关键词文章采集源码

核心方法:PHP+MYSQL开源超强SEO企业网站源码(关键词挖掘+几十套模板)

采集交流 • 优采云 发表了文章 • 0 个评论 • 188 次浏览 • 2020-11-07 10:02

模板介绍

PHP超级SEO企业网站源代码(带有关键词挖掘+数十个模板),该程序是基于PHP + MYSQL开发和生产的,其基础程序是THINIKPHP的二次开发。具有关键词挖掘功能!!!!这是非常强大的。 SEO网站的必备工具!此外,还有数十个前端模板。毫不夸张地说这是一个小型的自助式网站构建系统!

该程序的优点如下:

1、都是开源的,这很重要!

2、关键词挖掘功能。 (它比某些挖掘软件更强大)。根据第一点,您可以自己进行一些研究!!!

3、数十个前端模板,您可以根据需要更改它们。

谈论该程序的优缺点:

1、接口未充分优化,响应速度有点慢! (我不知道这是不是我的机器的问题)

2、前景模板几乎不起作用。 (使用一般企业站点时没问题)

下载说明

下载说明:

A:是的,是的,收录演示站的织梦模板已经过严格测试。效果图和演示站均来自模板,可以保证相同!我们没有对免费模板进行太多测试,请自行下载并测试!

由于该站点的客户服务人员精力有限,除了一些付费的织梦模板外,其他模板可免费共享,并且不提供技术支持。

A:我们网站上的模板标记为免费,并且减压密码直接共享。请仔细检查模板说明。

A:为了您的利益,请找出来!对您和我们都有好处!

A:现在联系我们!

在线客户服务 查看全部

PHP + MYSQL开源超级SEO企业网站源代码(关键词挖掘+数十个模板)

模板介绍

PHP超级SEO企业网站源代码(带有关键词挖掘+数十个模板),该程序是基于PHP + MYSQL开发和生产的,其基础程序是THINIKPHP的二次开发。具有关键词挖掘功能!!!!这是非常强大的。 SEO网站的必备工具!此外,还有数十个前端模板。毫不夸张地说这是一个小型的自助式网站构建系统!

该程序的优点如下:

1、都是开源的,这很重要!

2、关键词挖掘功能。 (它比某些挖掘软件更强大)。根据第一点,您可以自己进行一些研究!!!

3、数十个前端模板,您可以根据需要更改它们。

谈论该程序的优缺点:

1、接口未充分优化,响应速度有点慢! (我不知道这是不是我的机器的问题)

2、前景模板几乎不起作用。 (使用一般企业站点时没问题)

下载说明

下载说明:

A:是的,是的,收录演示站的织梦模板已经过严格测试。效果图和演示站均来自模板,可以保证相同!我们没有对免费模板进行太多测试,请自行下载并测试!

由于该站点的客户服务人员精力有限,除了一些付费的织梦模板外,其他模板可免费共享,并且不提供技术支持。

A:我们网站上的模板标记为免费,并且减压密码直接共享。请仔细检查模板说明。

A:为了您的利益,请找出来!对您和我们都有好处!

A:现在联系我们!

在线客户服务

教程:Python与seo工具脚本,360/搜狗相关搜索词采集源码参考

采集交流 • 优采云 发表了文章 • 0 个评论 • 543 次浏览 • 2020-10-25 11:01

与搜索引擎相关的搜索词应为[s5]扩展的类别,许多人正在寻找并选择使用,除了流行的与百度相关的搜索词采集之外,当然还有360个搜索引擎和Sogou搜索引擎,我当然知道方法,将来python的实现基本上是相同的,您唯一需要关心的就是单词本身和反爬坡的限制!

不,这是该败类在360搜索中的第二次推翻。请注意,这是第二次。在采集 360搜索问题和答案期间,处女第一次翻车或汽车翻车。我忘了伤疤真是太好了,太久了! !

360搜索会大力创造奇迹,而不是正确地,大力产生验证码。

此渣是在这里使用常规规则实现相关关键词采集的方法,参考了大量源代码,采用常规规则更加方便快捷!

360个搜索相关的关键词键源代码

re.findall(r'(.+?)</a>', html, re.S | re.I)

搜狗搜索相关的关键词关键源代码

您可以自己参考和学习,毕竟没有什么可谈论的!

附加与关键词 采集相关的360搜索源代码,以供参考和学习! PS:我没有写代码。顽固的学习被废除了。怎么写呢? !

#!/usr/bin/env python3

# -*- coding: utf-8 -*-

"""

360相关搜索词挖掘脚本(多线程版)

基于python3.8

需要安装requests模块

@author:微信/huguo00289

"""

import re

from queue import Queue

from threading import Thread

import requests,random

class Qh360Spider(Thread):

result = {} # 保存结果字典

seen = set() # 表示在队列中的关键词(已抓取或待抓取)

def __init__(self, kw_queue, loop, failed):

super(Qh360Spider, self).__init__()

self.kw_queue = kw_queue # 关键词队列

self.loop = loop # 循环挖词拓展次数

self.failed = failed # 保存查询失败的关键词文件

self.ua_list = [

'Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/535.1 (KHTML, like Gecko) Chrome/14.0.835.163 Safari/535.1',

'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/73.0.3683.103 Safari/537.36Chrome 17.0',

'Mozilla/5.0 (Macintosh; Intel Mac OS X 10_7_0) AppleWebKit/535.11 (KHTML, like Gecko) Chrome/17.0.963.56 Safari/535.11',

'Mozilla/5.0 (Windows NT 6.1; WOW64; rv:6.0) Gecko/20100101 Firefox/6.0Firefox 4.0.1',

'Mozilla/5.0 (Macintosh; Intel Mac OS X 10.6; rv:2.0.1) Gecko/20100101 Firefox/4.0.1',

'Mozilla/5.0 (Macintosh; U; Intel Mac OS X 10_6_8; en-us) AppleWebKit/534.50 (KHTML, like Gecko) Version/5.1 Safari/534.50',

'Mozilla/5.0 (Windows; U; Windows NT 6.1; en-us) AppleWebKit/534.50 (KHTML, like Gecko) Version/5.1 Safari/534.50',

'Opera/9.80 (Windows NT 6.1; U; en) Presto/2.8.131 Version/11.11',

]

def run(self): # 程序的执行流程

while True:

# 从队列里面获取一个关键词及其对应的当前拓展次数

kw, cloop = self.kw_queue.get()

print('CurLoop:{} Checking: {}'.format(cloop, kw))

query = 'https://www.so.com/s?q={}'.format(kw) # 构建含关键词的url

try:

source = self.download(query, timeout=10)

# source = self.download(query,timeout=10,user_agent=self.ua)

if source:

kw_list = self.extract(source)

print(kw_list)

self.filter(cloop, kw_list)

else:

# 获取源码失败,保存查询失败的关键词

self.failed.write('{}\n'.format(kw))

finally:

self.kw_queue.task_done()

def download(self, url, timeout=5, proxy=None, num_retries=5):

"""

通用网页源码下载函数

:param url: 要下载的url

:param timeout: 请求超时时间,单位/秒。可能某些网站的反应速度很慢,所以需要一个连接超时变量来处理。

:param user_agent: 用户代理信息,可以自定义是爬虫还是模拟用户

:param proxy: ip代理(http代理),访问某些国外网站的时候需要用到。必须是双元素元组或列表(‘ip:端口’,‘http/https’)

:param num_retries: 失败重试次数

:return: HTML网页源码

"""

headers = {

"Cookie": "QiHooGUID=41F80B0CCE5D43A22EEF0305A12CDE3F.1596003342506; __guid=15484592.2994995584481314300.1596003341831.5723; soid=TjzBKt3zrO-Rh1S7fXSb0S!6kmX5TlEerB2URZz9v4; __md=667cb161f9515972323507763d8fa7dd643a65bd2e88034.9; dpr=1; isafe=1; webp=1; _uc_m2=886a48052dbb9e2291f80055746e0d4f1f110f922b2f; _uc_mid=7cb161f953d8fa7dd643a65bd2e88034; __huid=11xZqhEl%2FfVeqclI4j%2BdQeQvX63Oph%2F%2BCVM5vxqYGxQI4%3D; Q=u%3Duhthb002%26n%3D%26le%3DAwH0ZGV5ZGR3WGDjpKRhL29g%26m%3DZGH5WGWOWGWOWGWOWGWOWGWOZGL0%26qid%3D144048053%26im%3D1_t018c25fbb66797efb2%26src%3D360chrome%26t%3D1; T=s%3D2afa764886f737dd5d23421c30f87a1f%26t%3D1595934758%26lm%3D0-1%26lf%3D2%26sk%3De485bbde46ac34fc27fc40215de76c44%26mt%3D1595934758%26rc%3D1%26v%3D2.0%26a%3D1; _S=tg75a7e3fmv0mfdfkt8jlpfpj6; stc_ls_sohome=RRzRSR!RTR(RUR_RVR; gtHuid=1; homeopenad=1; _pp_wd=1; _ga=GA1.2.607533084.1598082638; _gid=GA1.2.1887117715.1598082638; count=6; erules=p1-9%7Cp2-11%7Cp4-3%7Cecl-2%7Ckd-1%7Cp3-2",

'User-Agent': random.choice(self.ua_list)

}

try:

# 打开网页并读取内容存入html变量中

resp = requests.get(url, headers=headers, proxies=proxy, timeout=timeout)

print(resp.status_code)

except requests.RequestException as err:

print('Download error:', err)

html = None # 如果有异常,那么html肯定是没获取到的,所以赋值None

if num_retries > 0:

return self.download(url, timeout, proxy, num_retries - 1)

else:

html = resp.content.decode('utf-8')

#print(html)

return html

@staticmethod

def extract(html):

'''

提取关键词

:param html:搜索结果源码

:return:提取出来的相关关键词列表

'''

return re.findall(r'(.+?)</a>', html, re.S | re.I)

def filter(self, current_loop, kwlist):

'''

关键词过滤和统计函数

:param current_loop: 当前拓展的次数

:param kwlist: 提取出来的关键词列表

:return: None

'''

for kw in kwlist:

# 判断关键词是不是已经被抓取或者已经存在关键词队列

# 判断当前的拓展次数是否已经超过指定值

if current_loop 0:

print("有东西")

print('111')

save.write(line)

save.flush() # 刷新缓存,避免中途出错

save.close()

print('done,完成挖掘')

如果您无权访问ip代理,那么进行协调非常容易。毕竟,要大力生成验证码。尝试后,速度仍然可以,但是太容易被360搜索防爬升阻止。如果您想要正常且稳定的操作,则不知道如何访问代理IP,那么必须同时存在一个cookie库!

查看全部

Python和seo工具脚本,与360 / Sogou相关的搜索词采集源代码参考

与搜索引擎相关的搜索词应为[s5]扩展的类别,许多人正在寻找并选择使用,除了流行的与百度相关的搜索词采集之外,当然还有360个搜索引擎和Sogou搜索引擎,我当然知道方法,将来python的实现基本上是相同的,您唯一需要关心的就是单词本身和反爬坡的限制!

不,这是该败类在360搜索中的第二次推翻。请注意,这是第二次。在采集 360搜索问题和答案期间,处女第一次翻车或汽车翻车。我忘了伤疤真是太好了,太久了! !

360搜索会大力创造奇迹,而不是正确地,大力产生验证码。

此渣是在这里使用常规规则实现相关关键词采集的方法,参考了大量源代码,采用常规规则更加方便快捷!

360个搜索相关的关键词键源代码

re.findall(r'(.+?)</a>', html, re.S | re.I)

搜狗搜索相关的关键词关键源代码

您可以自己参考和学习,毕竟没有什么可谈论的!

附加与关键词 采集相关的360搜索源代码,以供参考和学习! PS:我没有写代码。顽固的学习被废除了。怎么写呢? !

#!/usr/bin/env python3

# -*- coding: utf-8 -*-

"""

360相关搜索词挖掘脚本(多线程版)

基于python3.8

需要安装requests模块

@author:微信/huguo00289

"""

import re

from queue import Queue

from threading import Thread

import requests,random

class Qh360Spider(Thread):

result = {} # 保存结果字典

seen = set() # 表示在队列中的关键词(已抓取或待抓取)

def __init__(self, kw_queue, loop, failed):

super(Qh360Spider, self).__init__()

self.kw_queue = kw_queue # 关键词队列

self.loop = loop # 循环挖词拓展次数

self.failed = failed # 保存查询失败的关键词文件

self.ua_list = [

'Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/535.1 (KHTML, like Gecko) Chrome/14.0.835.163 Safari/535.1',

'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/73.0.3683.103 Safari/537.36Chrome 17.0',

'Mozilla/5.0 (Macintosh; Intel Mac OS X 10_7_0) AppleWebKit/535.11 (KHTML, like Gecko) Chrome/17.0.963.56 Safari/535.11',

'Mozilla/5.0 (Windows NT 6.1; WOW64; rv:6.0) Gecko/20100101 Firefox/6.0Firefox 4.0.1',

'Mozilla/5.0 (Macintosh; Intel Mac OS X 10.6; rv:2.0.1) Gecko/20100101 Firefox/4.0.1',

'Mozilla/5.0 (Macintosh; U; Intel Mac OS X 10_6_8; en-us) AppleWebKit/534.50 (KHTML, like Gecko) Version/5.1 Safari/534.50',

'Mozilla/5.0 (Windows; U; Windows NT 6.1; en-us) AppleWebKit/534.50 (KHTML, like Gecko) Version/5.1 Safari/534.50',

'Opera/9.80 (Windows NT 6.1; U; en) Presto/2.8.131 Version/11.11',

]

def run(self): # 程序的执行流程

while True:

# 从队列里面获取一个关键词及其对应的当前拓展次数

kw, cloop = self.kw_queue.get()

print('CurLoop:{} Checking: {}'.format(cloop, kw))

query = 'https://www.so.com/s?q={}'.format(kw) # 构建含关键词的url

try:

source = self.download(query, timeout=10)

# source = self.download(query,timeout=10,user_agent=self.ua)

if source:

kw_list = self.extract(source)

print(kw_list)

self.filter(cloop, kw_list)

else:

# 获取源码失败,保存查询失败的关键词

self.failed.write('{}\n'.format(kw))

finally:

self.kw_queue.task_done()

def download(self, url, timeout=5, proxy=None, num_retries=5):

"""

通用网页源码下载函数

:param url: 要下载的url

:param timeout: 请求超时时间,单位/秒。可能某些网站的反应速度很慢,所以需要一个连接超时变量来处理。

:param user_agent: 用户代理信息,可以自定义是爬虫还是模拟用户

:param proxy: ip代理(http代理),访问某些国外网站的时候需要用到。必须是双元素元组或列表(‘ip:端口’,‘http/https’)

:param num_retries: 失败重试次数

:return: HTML网页源码

"""

headers = {

"Cookie": "QiHooGUID=41F80B0CCE5D43A22EEF0305A12CDE3F.1596003342506; __guid=15484592.2994995584481314300.1596003341831.5723; soid=TjzBKt3zrO-Rh1S7fXSb0S!6kmX5TlEerB2URZz9v4; __md=667cb161f9515972323507763d8fa7dd643a65bd2e88034.9; dpr=1; isafe=1; webp=1; _uc_m2=886a48052dbb9e2291f80055746e0d4f1f110f922b2f; _uc_mid=7cb161f953d8fa7dd643a65bd2e88034; __huid=11xZqhEl%2FfVeqclI4j%2BdQeQvX63Oph%2F%2BCVM5vxqYGxQI4%3D; Q=u%3Duhthb002%26n%3D%26le%3DAwH0ZGV5ZGR3WGDjpKRhL29g%26m%3DZGH5WGWOWGWOWGWOWGWOWGWOZGL0%26qid%3D144048053%26im%3D1_t018c25fbb66797efb2%26src%3D360chrome%26t%3D1; T=s%3D2afa764886f737dd5d23421c30f87a1f%26t%3D1595934758%26lm%3D0-1%26lf%3D2%26sk%3De485bbde46ac34fc27fc40215de76c44%26mt%3D1595934758%26rc%3D1%26v%3D2.0%26a%3D1; _S=tg75a7e3fmv0mfdfkt8jlpfpj6; stc_ls_sohome=RRzRSR!RTR(RUR_RVR; gtHuid=1; homeopenad=1; _pp_wd=1; _ga=GA1.2.607533084.1598082638; _gid=GA1.2.1887117715.1598082638; count=6; erules=p1-9%7Cp2-11%7Cp4-3%7Cecl-2%7Ckd-1%7Cp3-2",

'User-Agent': random.choice(self.ua_list)

}

try:

# 打开网页并读取内容存入html变量中

resp = requests.get(url, headers=headers, proxies=proxy, timeout=timeout)

print(resp.status_code)

except requests.RequestException as err:

print('Download error:', err)

html = None # 如果有异常,那么html肯定是没获取到的,所以赋值None

if num_retries > 0:

return self.download(url, timeout, proxy, num_retries - 1)

else:

html = resp.content.decode('utf-8')

#print(html)

return html

@staticmethod

def extract(html):

'''

提取关键词

:param html:搜索结果源码

:return:提取出来的相关关键词列表

'''

return re.findall(r'(.+?)</a>', html, re.S | re.I)

def filter(self, current_loop, kwlist):

'''

关键词过滤和统计函数

:param current_loop: 当前拓展的次数

:param kwlist: 提取出来的关键词列表

:return: None

'''

for kw in kwlist:

# 判断关键词是不是已经被抓取或者已经存在关键词队列

# 判断当前的拓展次数是否已经超过指定值

if current_loop 0:

print("有东西")

print('111')

save.write(line)

save.flush() # 刷新缓存,避免中途出错

save.close()

print('done,完成挖掘')

如果您无权访问ip代理,那么进行协调非常容易。毕竟,要大力生成验证码。尝试后,速度仍然可以,但是太容易被360搜索防爬升阻止。如果您想要正常且稳定的操作,则不知道如何访问代理IP,那么必须同时存在一个cookie库!

解决办法:网站关键词排名下降可能是哪些原因导致的?

采集交流 • 优采云 发表了文章 • 0 个评论 • 488 次浏览 • 2020-09-08 04:16

在优化网站的过程中,我们经常遇到网站的排名下降关键词。除了搜索引擎本身的问题外,我们还需要从网站本身进行检查和分析。那么,网站 关键词排名下降的可能原因是什么?接下来,编辑者将与您分享可能导致网站 关键词排名下降的原因,让我们看看!

1.服务器原因

网站服务器不稳定,经常无法打开网站,或者打开速度太慢,服务器受到攻击等。这时,您需要联系网站建设部门来更改服务器或维护服务器。

2. 网站修订

网站修订后,关键词排名下降的机会非常高。

3. 网站 TDK进行更改

网站的TDK已修改,网站的TDK非常重要。如果您不加警告地对其进行修改,则肯定会导致网站 关键词的排名下降。

4. 文章的内容尚未修改,采集,无关的内容

网站的文章内容,当使用直接采集或撰写与网站 关键词无关的内容时,百度将被判定为欺诈行为,因此请继续进行网站 文章更新时,必须根据标准伪原创或原创写入网站的内容。

5. 网站友情链接中有灰色或降级的网站

排名下降后,检查网站的友情链接以查看是否有灰色或降级的网站和友情链接网站被挂断。如果有,则需要及时删除和替换。

6. 网站挂断了

网站的赛马停赛常常导致关键词排名迅速下降。检查网站和收录的快照时,还应检查网站是否已暂停,并发现网站挂断后需要及时处理。 查看全部

网站 关键词排名下降的可能原因是什么?

在优化网站的过程中,我们经常遇到网站的排名下降关键词。除了搜索引擎本身的问题外,我们还需要从网站本身进行检查和分析。那么,网站 关键词排名下降的可能原因是什么?接下来,编辑者将与您分享可能导致网站 关键词排名下降的原因,让我们看看!

1.服务器原因

网站服务器不稳定,经常无法打开网站,或者打开速度太慢,服务器受到攻击等。这时,您需要联系网站建设部门来更改服务器或维护服务器。

2. 网站修订

网站修订后,关键词排名下降的机会非常高。

3. 网站 TDK进行更改

网站的TDK已修改,网站的TDK非常重要。如果您不加警告地对其进行修改,则肯定会导致网站 关键词的排名下降。

4. 文章的内容尚未修改,采集,无关的内容

网站的文章内容,当使用直接采集或撰写与网站 关键词无关的内容时,百度将被判定为欺诈行为,因此请继续进行网站 文章更新时,必须根据标准伪原创或原创写入网站的内容。

5. 网站友情链接中有灰色或降级的网站

排名下降后,检查网站的友情链接以查看是否有灰色或降级的网站和友情链接网站被挂断。如果有,则需要及时删除和替换。

6. 网站挂断了

网站的赛马停赛常常导致关键词排名迅速下降。检查网站和收录的快照时,还应检查网站是否已暂停,并发现网站挂断后需要及时处理。

最新版本:PHP小说网站源码 自动生成txt+zip压缩+全自动采集+漂亮WAP

采集交流 • 优采云 发表了文章 • 0 个评论 • 399 次浏览 • 2020-09-07 20:12

深度定制的新颖站点,全自动采集各种站点,可以自动为主页,类别,目录,排名,站点地图页面,整个站点的拼音目录,伪静态章节页面自动生成静态html。生成小说txt文件,自动生成zip压缩包。此源代码功能非常强大!带来一个非常漂亮的移动页面!使用采集规则+自动调整!超级强大,可以使用所有采集规则,并且全自动采集和存储,非常易于使用,特别适合优采云维护!对于一个新颖的网站,好的程序无话可说。

其他功能:

(1)自动为主页,类别,目录,排名,站点地图页面(类别页面,小说封面,作者页面)生成静态html,如果html文件在设置的时间后不存在或未更新,自动更新一次。如果有采集,小说的封面和相应的类别页面将在采集时自动更新),直接通过PHP调用html文件,而不是在根目录下生成该文件,访问速度与纯静态无异,可以保证源代码文件管理很方便,同时减轻了服务器压力,还可以简化对统计信息的访问并提高搜索引擎的识别率。

([2)全站点拼音目录,各章页面均为伪静态。

([3)自动生成新颖的txt文件,或者您可以在后台重新生成txt文件。

([4)自动生成小说关键词和关键词自动内部链接。

([5)自动伪原创单词替换(在采集时替换)。

([6)添加新功能,例如小说的总点击,每月点击,每周点击,总推荐,每月推荐,每周推荐统计和作者推荐统计。

(7)借助CNZZ的统计插件,可以方便地实现对新颖下载和藏书的详细统计。

(8)该程序的自动采集在市场优采云,Guanguan,采集等市场中并不常见,而是基于DEDE原创采集功能的二次开发[The k1]模块可以有效地确保章节内容的完整性,避免章节重复,章节内容无内容,章节乱码等;一天24小时采集可以达到250,000至300,000个章节。

安装说明:

1、上传到网站根目录

2、使用phpMyadmin导入数据库文件xiaoshuo.sql

3、修改数据库链接文件/data/common.inc.php

(请记住不要使用记事本进行修改,否则可能不会显示验证码,建议使用记事本++)

4、背景目录/admin/index.php

帐户管理员密码admin

查看全部

PHP小说网站源代码自动生成txt + zip压缩+自动采集 +美丽的WAP

深度定制的新颖站点,全自动采集各种站点,可以自动为主页,类别,目录,排名,站点地图页面,整个站点的拼音目录,伪静态章节页面自动生成静态html。生成小说txt文件,自动生成zip压缩包。此源代码功能非常强大!带来一个非常漂亮的移动页面!使用采集规则+自动调整!超级强大,可以使用所有采集规则,并且全自动采集和存储,非常易于使用,特别适合优采云维护!对于一个新颖的网站,好的程序无话可说。

其他功能:

(1)自动为主页,类别,目录,排名,站点地图页面(类别页面,小说封面,作者页面)生成静态html,如果html文件在设置的时间后不存在或未更新,自动更新一次。如果有采集,小说的封面和相应的类别页面将在采集时自动更新),直接通过PHP调用html文件,而不是在根目录下生成该文件,访问速度与纯静态无异,可以保证源代码文件管理很方便,同时减轻了服务器压力,还可以简化对统计信息的访问并提高搜索引擎的识别率。

([2)全站点拼音目录,各章页面均为伪静态。

([3)自动生成新颖的txt文件,或者您可以在后台重新生成txt文件。

([4)自动生成小说关键词和关键词自动内部链接。

([5)自动伪原创单词替换(在采集时替换)。

([6)添加新功能,例如小说的总点击,每月点击,每周点击,总推荐,每月推荐,每周推荐统计和作者推荐统计。

(7)借助CNZZ的统计插件,可以方便地实现对新颖下载和藏书的详细统计。

(8)该程序的自动采集在市场优采云,Guanguan,采集等市场中并不常见,而是基于DEDE原创采集功能的二次开发[The k1]模块可以有效地确保章节内容的完整性,避免章节重复,章节内容无内容,章节乱码等;一天24小时采集可以达到250,000至300,000个章节。

安装说明:

1、上传到网站根目录

2、使用phpMyadmin导入数据库文件xiaoshuo.sql

3、修改数据库链接文件/data/common.inc.php

(请记住不要使用记事本进行修改,否则可能不会显示验证码,建议使用记事本++)

4、背景目录/admin/index.php

帐户管理员密码admin

技巧干货:网站SEO关键词排名稳定有哪些技巧?

采集交流 • 优采云 发表了文章 • 0 个评论 • 175 次浏览 • 2020-09-05 21:00

网站优化的目的是为了获得排名和转化率。这是许多公司想要的效果。如果您希望网站排名靠前,请首先让搜索引擎青睐我们的网站,以便该产品可以赢得声誉。那么,网站 SEO 关键词排名稳定的技能是什么?接下来,编辑器将与您分享网站 SEO 关键词排名稳定性的技巧,让我们一起来看看!

1、放弃采集 文章

现在,搜索引擎一直在强调网站的用户体验。如果网站中有很多采集 文章,则此网站的用户体验绝对不高,一个网站长时间没有用户显示,或者[k2跳出率高,在网站或文章中直接有很多伪原创或文章直接出现,这势必会影响网站的排名。追随高质量原创 文章是稳定网站排名的关键。

2、保持适度的优化

一些网站管理员渴望在优化时快速获得成功并快速获利。这个想法很容易导致过度优化。过度优化是许多网站排名下降的重点。 网站 SEO非常有可能被优化。可能是关键词堆叠,或者是网站链接优化。优化必须适度,有规律,循序渐进,并制定高质量的网站计划,以有效防止过度。

3、 网站高质量的结构

网站的结构也会在一定程度上影响网站的排名。在网站中浏览时,搜索引擎和用户必须受网站结构的影响。如果网站的结构不好,则用户和搜索引擎在浏览时或多或少会有某些问题。例如,在网站中的导航无法引导用户浏览,并且用户无法在网站中准确地找到他们所需的信息。 查看全部

网站 SEO 关键词排名稳定性有哪些技术?

网站优化的目的是为了获得排名和转化率。这是许多公司想要的效果。如果您希望网站排名靠前,请首先让搜索引擎青睐我们的网站,以便该产品可以赢得声誉。那么,网站 SEO 关键词排名稳定的技能是什么?接下来,编辑器将与您分享网站 SEO 关键词排名稳定性的技巧,让我们一起来看看!

1、放弃采集 文章

现在,搜索引擎一直在强调网站的用户体验。如果网站中有很多采集 文章,则此网站的用户体验绝对不高,一个网站长时间没有用户显示,或者[k2跳出率高,在网站或文章中直接有很多伪原创或文章直接出现,这势必会影响网站的排名。追随高质量原创 文章是稳定网站排名的关键。

2、保持适度的优化

一些网站管理员渴望在优化时快速获得成功并快速获利。这个想法很容易导致过度优化。过度优化是许多网站排名下降的重点。 网站 SEO非常有可能被优化。可能是关键词堆叠,或者是网站链接优化。优化必须适度,有规律,循序渐进,并制定高质量的网站计划,以有效防止过度。

3、 网站高质量的结构

网站的结构也会在一定程度上影响网站的排名。在网站中浏览时,搜索引擎和用户必须受网站结构的影响。如果网站的结构不好,则用户和搜索引擎在浏览时或多或少会有某些问题。例如,在网站中的导航无法引导用户浏览,并且用户无法在网站中准确地找到他们所需的信息。

分享文章:帝国CMS高仿短文学网文章资讯源码

采集交流 • 优采云 发表了文章 • 0 个评论 • 214 次浏览 • 2020-08-31 19:26

源代码描述:

帝国cms高仿短文学网站源代码,包括手机+详细用法教程

应用范围: 文学网站源代码,情感网站源代码,情感文学源代码,短文学作品网站源代码,文章门户网站源代码

操作环境: PHP,MYsql

其他说明: Empire cms高仿短文学网站的源代码,包括移动终端+详细的使用教程,没有数据,请与大家共享!

在中国有许多种开源网站程序,Empire cms被认为是最杰出的程序. 由于此cms,它功能强大且非常安全. 目前,大多数网站功能都可以使用此程序来实现. 据说帝国是稳定和文明的,基本上没有主要的安全漏洞. 借助此cms,不必担心网站被黑客入侵. 网站具有出色的安全性,并且不容易出现问题. 网站静态网页的生成速度也非常好. 当前的官方测试可以支持数以千万计的数据,适合于长期的开发和运营. 一般来说,Empire cms是一个出色的网站cms.

模板功能:

1. 网站程序是使用最安全,稳定和强大的帝国cms7.2系统进行深度开发的.

2. 该程序的网站程序包括PC计算机和手机程序. 如今,当移动流量赶上并超过了PC时,移动版本的网站程序将为您带来可观的流量和收益. ,目前手机流量的市场价格为10,000 ip时为500元.

3全站共有300列,涵盖了文学中的各种流行关键字. 每列都可以进行个性化SEO,并且您可以设置各种受欢迎的关键字. 该网站程序共有300列,并且我们已经手动优化和优化了每一列(手动设置列目标,设置列关键字以及为每个列设置页面描述).

4网站样式优雅简单,非常受欢迎. 该网站是一个完整的系统,包括多个页面模板,多个网站功能,与其他网站完全不同,仅显示几个页面模板. (Empire cms开发的PC终端程序,Empire cms开发的移动终端程序,精美的会员系统,24小时无人值守的智能采集自动软件更新)

5网站已经完成了广告空间,网站管理员可以在网站上放置广告代码以赚钱.

源图像: 查看全部

帝国cms高仿短文学网站文章信息源代码

源代码描述:

帝国cms高仿短文学网站源代码,包括手机+详细用法教程

应用范围: 文学网站源代码,情感网站源代码,情感文学源代码,短文学作品网站源代码,文章门户网站源代码

操作环境: PHP,MYsql

其他说明: Empire cms高仿短文学网站的源代码,包括移动终端+详细的使用教程,没有数据,请与大家共享!

在中国有许多种开源网站程序,Empire cms被认为是最杰出的程序. 由于此cms,它功能强大且非常安全. 目前,大多数网站功能都可以使用此程序来实现. 据说帝国是稳定和文明的,基本上没有主要的安全漏洞. 借助此cms,不必担心网站被黑客入侵. 网站具有出色的安全性,并且不容易出现问题. 网站静态网页的生成速度也非常好. 当前的官方测试可以支持数以千万计的数据,适合于长期的开发和运营. 一般来说,Empire cms是一个出色的网站cms.

模板功能:

1. 网站程序是使用最安全,稳定和强大的帝国cms7.2系统进行深度开发的.

2. 该程序的网站程序包括PC计算机和手机程序. 如今,当移动流量赶上并超过了PC时,移动版本的网站程序将为您带来可观的流量和收益. ,目前手机流量的市场价格为10,000 ip时为500元.

3全站共有300列,涵盖了文学中的各种流行关键字. 每列都可以进行个性化SEO,并且您可以设置各种受欢迎的关键字. 该网站程序共有300列,并且我们已经手动优化和优化了每一列(手动设置列目标,设置列关键字以及为每个列设置页面描述).

4网站样式优雅简单,非常受欢迎. 该网站是一个完整的系统,包括多个页面模板,多个网站功能,与其他网站完全不同,仅显示几个页面模板. (Empire cms开发的PC终端程序,Empire cms开发的移动终端程序,精美的会员系统,24小时无人值守的智能采集自动软件更新)

5网站已经完成了广告空间,网站管理员可以在网站上放置广告代码以赚钱.

源图像:

总结:Python数据采集案例(1):微博热搜榜采集

采集交流 • 优采云 发表了文章 • 0 个评论 • 360 次浏览 • 2020-08-31 13:03

实现目标

本案例通过图片和文字详细介绍了网络请求和分析的方法. 实现该目标的要求是通过网络请求获取微博热搜索列表中的前50个热搜索关键字,并将结果打印到控制台中.

实现过程

通常,数据采集采集器的实现过程包括以下步骤:

接下来,我们按照上述步骤一步一步完成.

确定数据所在的网址

打开微博热点搜索列表,即网址为:

首先,我们需要确定目标数据是存在于页面上还是通过Ajax加载. 我们可以在浏览器中右键单击(建议使用Chrome浏览器),然后选择“查看网页源代码”.

这时,浏览器将打开一个新页面,并将视图源部分添加到Url(网页地址)之前,并且该网页中显示的关键字是当前网页的源代码.

我们使用快捷键Ctrl + F打开搜索框,并在网页的源代码中搜索显示在顶部搜索页面上的文本. 例如,搜索排名最高的“在神仙桥上发现的北宋古墓”,您可以找到网页的源代码中存在关键字,这意味着热门搜索列表直接加载到页面上,而不是通过Ajax. 目前,我们只需要直接请求网页的URL即可获取热门搜索列表数据.

网页请求

下面,我们使用请求模块执行网页请求并打印请求结果. 代码如下:

import requests

if __name__ == "__main__":

response = requests.get("https://s.weibo.com/top/summary")

print(response.content.decode())

在印刷的内容中,我们通过搜索再次发现了“北宋发现的穿越神仙桥的古墓”,这表明我们的请求成功获得了热门搜索数据,没有任何问题.

网页分析

再次返回浏览器,右键单击并选择“检查”以打开浏览器控制台(或直接使用快捷键F12打开控制台).

选择元素选择工具.

在元素选择模式下(元素选择工具的小箭头为蓝色),单击我们需要采集的信息.

这时,浏览器控制台将找到目标信息所在的标签.

我们右键单击标签,选择“复制”,然后选择“复制选择器”以复制标签的CSS选择器路径. 该路径用于定位当前标签. 例如,第一个热搜索关键字所在的标签的CSS选择器为:

#pl_top_realtimehot > table > tbody > tr:nth-child(2) > td.td-02 > a

#pl_top_realtimehot表示ID为pl_top_realtimehot的标签,即下图第一行中的div标签;> table表示当前标签的下一层的表标签,即下图的第二行; tr: nth -child(2)表示当前标签下的第二个tr标签,即下图中选择的tr标签.

通过观察网络结构,我们可以发现每个热搜索在tbody标签下面是一个独立的tr标签;因此,要同时获得不同的热门搜索关键字,我们只需要不再限制指定的tr即可. 只需删除标签,即删除tr: nth-child(2)中的: nth-child(2)即可. CSS选择器路径.

#pl_top_realtimehot > table > tbody > tr > td.td-02 > a

在浏览器控制台的“元素”选项卡中,使用Ctrl + F快捷键打开搜索框,然后在搜索框中搜索修改后的CSS选择器路径. 可获得51个结果,表明可以同时使用修改后的CSS选择器. 匹配所有热门搜索关键字.

下面,我们使用Python的第三方模块-BeautifulSoup模块(pip install命令: pip install BeautifulSoup4)实施分析,其中包括以下请求代码:

import requests

from bs4 import BeautifulSoup

if __name__ == "__main__":

response = requests.get("https://s.weibo.com/top/summary")

bs = BeautifulSoup(response.content.decode(), 'lxml')

for keyword_label in bs.select("#pl_top_realtimehot > table > tbody > tr > td.td-02 > a"):

print(keyword_label.text)

运行结果已经可以将所有热门搜索打印到控制台,从而实现当前需求.

10个关键词把握2020中国经济走势

北宋古墓发现过仙桥

香港各界发起联署支持国家安全立法

马路惊现非洲雄狮

澳门所有大中小学升国旗唱国歌全覆盖

......

这一系列案例采集中的所有数据只能用于学习和研究目的!

案例要求说明: 因此,微博热点搜索列表是实时更新的,因此相对完整的采集要求如下: 每3分钟采集一次微博热点搜索列表中排名前49位的热门搜索(忽略广告第3条中的信息),并将结果存储在数据库中. 该数据库至少应收录采集时间,等级(等级),关键字(关键字),受欢迎程度(热门),类型(类型)和其他字段. 完整的案例将在后续内容中进行解释.

案例说明的解释: 作为第一个案例,本文通过图片和文字详细解释了每个步骤,随后的案例将集中在思想上.

扩展链接是Github项目链接. 查看全部

Python数据采集案例(1): 微博热点搜索列表采集

实现目标

本案例通过图片和文字详细介绍了网络请求和分析的方法. 实现该目标的要求是通过网络请求获取微博热搜索列表中的前50个热搜索关键字,并将结果打印到控制台中.

实现过程

通常,数据采集采集器的实现过程包括以下步骤:

接下来,我们按照上述步骤一步一步完成.

确定数据所在的网址

打开微博热点搜索列表,即网址为:

首先,我们需要确定目标数据是存在于页面上还是通过Ajax加载. 我们可以在浏览器中右键单击(建议使用Chrome浏览器),然后选择“查看网页源代码”.

这时,浏览器将打开一个新页面,并将视图源部分添加到Url(网页地址)之前,并且该网页中显示的关键字是当前网页的源代码.

我们使用快捷键Ctrl + F打开搜索框,并在网页的源代码中搜索显示在顶部搜索页面上的文本. 例如,搜索排名最高的“在神仙桥上发现的北宋古墓”,您可以找到网页的源代码中存在关键字,这意味着热门搜索列表直接加载到页面上,而不是通过Ajax. 目前,我们只需要直接请求网页的URL即可获取热门搜索列表数据.

网页请求

下面,我们使用请求模块执行网页请求并打印请求结果. 代码如下:

import requests

if __name__ == "__main__":

response = requests.get("https://s.weibo.com/top/summary";)

print(response.content.decode())

在印刷的内容中,我们通过搜索再次发现了“北宋发现的穿越神仙桥的古墓”,这表明我们的请求成功获得了热门搜索数据,没有任何问题.

网页分析

再次返回浏览器,右键单击并选择“检查”以打开浏览器控制台(或直接使用快捷键F12打开控制台).

选择元素选择工具.

在元素选择模式下(元素选择工具的小箭头为蓝色),单击我们需要采集的信息.

这时,浏览器控制台将找到目标信息所在的标签.

我们右键单击标签,选择“复制”,然后选择“复制选择器”以复制标签的CSS选择器路径. 该路径用于定位当前标签. 例如,第一个热搜索关键字所在的标签的CSS选择器为:

#pl_top_realtimehot > table > tbody > tr:nth-child(2) > td.td-02 > a

#pl_top_realtimehot表示ID为pl_top_realtimehot的标签,即下图第一行中的div标签;> table表示当前标签的下一层的表标签,即下图的第二行; tr: nth -child(2)表示当前标签下的第二个tr标签,即下图中选择的tr标签.

通过观察网络结构,我们可以发现每个热搜索在tbody标签下面是一个独立的tr标签;因此,要同时获得不同的热门搜索关键字,我们只需要不再限制指定的tr即可. 只需删除标签,即删除tr: nth-child(2)中的: nth-child(2)即可. CSS选择器路径.

#pl_top_realtimehot > table > tbody > tr > td.td-02 > a

在浏览器控制台的“元素”选项卡中,使用Ctrl + F快捷键打开搜索框,然后在搜索框中搜索修改后的CSS选择器路径. 可获得51个结果,表明可以同时使用修改后的CSS选择器. 匹配所有热门搜索关键字.

下面,我们使用Python的第三方模块-BeautifulSoup模块(pip install命令: pip install BeautifulSoup4)实施分析,其中包括以下请求代码:

import requests

from bs4 import BeautifulSoup

if __name__ == "__main__":

response = requests.get("https://s.weibo.com/top/summary";)

bs = BeautifulSoup(response.content.decode(), 'lxml')

for keyword_label in bs.select("#pl_top_realtimehot > table > tbody > tr > td.td-02 > a"):

print(keyword_label.text)

运行结果已经可以将所有热门搜索打印到控制台,从而实现当前需求.

10个关键词把握2020中国经济走势

北宋古墓发现过仙桥

香港各界发起联署支持国家安全立法

马路惊现非洲雄狮

澳门所有大中小学升国旗唱国歌全覆盖

......

这一系列案例采集中的所有数据只能用于学习和研究目的!

案例要求说明: 因此,微博热点搜索列表是实时更新的,因此相对完整的采集要求如下: 每3分钟采集一次微博热点搜索列表中排名前49位的热门搜索(忽略广告第3条中的信息),并将结果存储在数据库中. 该数据库至少应收录采集时间,等级(等级),关键字(关键字),受欢迎程度(热门),类型(类型)和其他字段. 完整的案例将在后续内容中进行解释.

案例说明的解释: 作为第一个案例,本文通过图片和文字详细解释了每个步骤,随后的案例将集中在思想上.

扩展链接是Github项目链接.

石头科技 - 舆情分析小助手(php+mysql) v20200513

采集交流 • 优采云 发表了文章 • 0 个评论 • 261 次浏览 • 2020-08-31 03:20

Stone Technology-可以循环监视舆论分析助手,第一次采集指定网站的公开信息标题,并根据关键字和过滤词过滤出用户所需的信息和链接,并提示使用人员. 新闻和民意管理人员尽快做出响应很方便. 由于其简单的操作,超小的尺寸以及其他原因,该程序已被众多用户所喜爱. 六年之后,Stone Technology一直没有停止更新. 我衷心希望该程序可以为开发人员提供更方便的操作环境. 欢迎需要此舆论分析系统下载和使用的朋友.

[操作技巧]

一个,安装

1. 将SQL文件夹中的数据表导入数据库.

2. 将文件复制到Web目录.

3. 修改SQL文件夹中host.php文件中的数据库帐户参数.

4. 初始帐户admin 111111(在USER和JSB库中修改).

第二,使用

1. 设置关键字,输入您要注意的关键字或必须注意的单词的组合.

2. 设置过滤词,输入需要过滤的词,例如关注“国内选举”的内容,可以屏蔽“美国”和“台湾”等词.

3. 设置监视URL和其他参数,包括: 新闻列表页面地址,页面分段代码(程序开发人员可以提供付费服务).

4. 单击监视并在右上角搜索以执行特定任务.

三,升级服务

(以下服务内容,程序开发人员可以提供付费服务)

1. 监视URL和其他参数,包括: 新闻列表页面的地址以及页面的分段代码.

2. 后台在线监控.

3. 关键数据邮箱提醒功能. 查看全部

Stone Technology-舆论分析助手(php + mysql)v20200513

Stone Technology-可以循环监视舆论分析助手,第一次采集指定网站的公开信息标题,并根据关键字和过滤词过滤出用户所需的信息和链接,并提示使用人员. 新闻和民意管理人员尽快做出响应很方便. 由于其简单的操作,超小的尺寸以及其他原因,该程序已被众多用户所喜爱. 六年之后,Stone Technology一直没有停止更新. 我衷心希望该程序可以为开发人员提供更方便的操作环境. 欢迎需要此舆论分析系统下载和使用的朋友.

[操作技巧]

一个,安装

1. 将SQL文件夹中的数据表导入数据库.

2. 将文件复制到Web目录.

3. 修改SQL文件夹中host.php文件中的数据库帐户参数.

4. 初始帐户admin 111111(在USER和JSB库中修改).

第二,使用

1. 设置关键字,输入您要注意的关键字或必须注意的单词的组合.

2. 设置过滤词,输入需要过滤的词,例如关注“国内选举”的内容,可以屏蔽“美国”和“台湾”等词.

3. 设置监视URL和其他参数,包括: 新闻列表页面地址,页面分段代码(程序开发人员可以提供付费服务).

4. 单击监视并在右上角搜索以执行特定任务.

三,升级服务

(以下服务内容,程序开发人员可以提供付费服务)

1. 监视URL和其他参数,包括: 新闻列表页面的地址以及页面的分段代码.

2. 后台在线监控.

3. 关键数据邮箱提醒功能.

解读:php实现手动获取生成文章主题关键词功能的深入剖析

采集交流 • 优采云 发表了文章 • 0 个评论 • 193 次浏览 • 2020-08-30 07:18

:/// php 实现手动获取生成文章主题关键词功能的深入剖析页面导航: 正文内容php 自动生成关键词 php 实现手动获取生成文章主题关键词功能 的深入剖析 本篇文章是对php 实现手动获取生成文章主题关键词功能进行了详尽的剖析介 绍,需要的同事参考下 以前写程序仍然在逃避这个问题,tag 什么的都是要求使用程序的人自行输 入,对于个别优采云及为了程序的体验,则是希望可以有手动生成文章关键词, 自动获取文章tag 的类似功能,这次为了迎接新的项目,所以忙活了一晚上, 研究了一下这个功能。 要实现手动获取关键词的功能,大概可以分成三步 1,通过动词算法将标题和内容分别进行分割,提取出关键词和频率。当前主要 的两个算法是中科院的ICTCLAS 和隐马尔可夫模型。但这两个都很高档,有一 定的门槛,且都是只支持C++/JAVA。基于PHP 的当前有两个是值得推荐的 PSCWS 和HTTPCWS。 SCWS 于2008-03-08 发布1.0.0 正式版,到现今最新版本 已经到了1.0.4。PSCWS 是它的PHP 版。而HTTPCWS 是张宴开发的,之前叫 PHPCWS。

PHPCWS 先使用“ICTCLAS 3.0 共享版中文分词算法”的API 进行初次 分词处理,再使用自行编撰的“逆向最大匹配算法”对动词和进行成语合并处 理,并降低标点符号过滤功能,得出动词结果。不过很遗憾目前仅支持Linux 系统,尚未移植到win 平台上。 2,将提取结果与现有词库进行比较,处理,去除无用的词得到最符合规则的关 键词。这里主要就是要看词库了,我们可以自己定义词库,也可以使用现有的 成熟词库。比如新浪和网易博客都有这个功能,。他们动词应当有不错的词库, 因为她们都是大网站,而我呢,区区一个小程序员,不可能搞到哪些权威的词 库,所以只能从现有的开源程序上入手,看看她们的词库。 3,在处理后的提取结果中选择适当的作为最终的关键词,得到最符合当前内容 的关键词,在这个阶段就是具体情况具体剖析了,无论如何也不可能达到人的 那种智能化。最多是。当前PHP 类CMS 都自有自己的提取关键词系统。 目前在网路上留传最广的是DEDECMS 的动词源码,我做了测试,发现相当的 呆,效果太不好。它先设置一个关键词宽度,确定获取关键词的数目,然后取 词,它觉得标题分好的词就是所需关键词,在加上从正文中读取关键词只抵达 到这个所设置的宽度,就是最终关键词了。

另外类似“我们”等无意义的词也 没有清除掉提取并被列为关键词的频度很高,甚至有时候就会把空格的HTML 出来做为关键词,亟待改进。不过若果作为辅助功能,它早已挺好了。而discuz 的稍为好一些,但是discuz 并没有提供源码,只是提供了一个在线 api。 而dede 的副词也有好几个版本,最好的应当是最新版的吧,出现频度哪些都有 了,下面就以dede5.7 的动词和discuz 的api 的结果对比下 测试事例: $title="THINKPHP 官方正式停止对2.0 版本的支持"; $body="了更好地做好ThinkPHP 框架的开发、维护和支持工作,官方宣布从 2012 对2.0及之前版本的维护和支持,为了节能低碳考虑,同 时也取消官网的相应版本和文档下载。 就此悼念那些年,曾经一起开发的ThinkPHP 版本吧! 关于ThinkPHP 2.0 版本 ThinkPHP 诞生于2006 年,致力于WEB 应用的快速开发,其2.0 版本发布于 2009 年10 ,在之前的1.*版本上完成新的构建和飞越,当时是一次划时代的版本,为新版奠定了基础,同时也积累了较多的用户群和网站,随着框 架的快速更新,和新版2.1、2.2 和3.0 版本的相继发布,预示着ThinkPHP 3.0时代到来了,2.0 的生命周期宣告结束。

但基本上2.0 的好多功能都延续或 者建立到2.1 版本中了,从2.0 版本升级到2.1 和2.2 版本也相对轻松。2.2 版本是2.*版本的最终版本,不再更新功能,仅做BUG 修复。"; 一、dede 分词 将结果排序后如下 標題Array 对此怎么取出最终的须要的关键词呢?初步思路是先除去“的”,“些”这些 词,再根据内容的排序次序,依次看分到是否出现在标题中出现即为所需的, 这样可以取出一定量的词最为最终关键词。如上结果我们可以得到 版本 thinkphp 2.0 支持 停止 五个关键词。看起来结果还是可以接受的。 二、在来看discuz 的,利用api 得到的是一个xml 文档,解析后得到的关键词 的、快速、版本升级、开发、用户五个词,第一个是“的”...... 对比这两种方法发觉第一种dede+后续处理的较为接近文档的内容,应该是稍 好一些,而discuz 的偏离了文章的主题,但是其取到词有一定的热门性 查看全部

php实现手动获取生成文章主题关键词功能的深入剖析

:/// php 实现手动获取生成文章主题关键词功能的深入剖析页面导航: 正文内容php 自动生成关键词 php 实现手动获取生成文章主题关键词功能 的深入剖析 本篇文章是对php 实现手动获取生成文章主题关键词功能进行了详尽的剖析介 绍,需要的同事参考下 以前写程序仍然在逃避这个问题,tag 什么的都是要求使用程序的人自行输 入,对于个别优采云及为了程序的体验,则是希望可以有手动生成文章关键词, 自动获取文章tag 的类似功能,这次为了迎接新的项目,所以忙活了一晚上, 研究了一下这个功能。 要实现手动获取关键词的功能,大概可以分成三步 1,通过动词算法将标题和内容分别进行分割,提取出关键词和频率。当前主要 的两个算法是中科院的ICTCLAS 和隐马尔可夫模型。但这两个都很高档,有一 定的门槛,且都是只支持C++/JAVA。基于PHP 的当前有两个是值得推荐的 PSCWS 和HTTPCWS。 SCWS 于2008-03-08 发布1.0.0 正式版,到现今最新版本 已经到了1.0.4。PSCWS 是它的PHP 版。而HTTPCWS 是张宴开发的,之前叫 PHPCWS。

PHPCWS 先使用“ICTCLAS 3.0 共享版中文分词算法”的API 进行初次 分词处理,再使用自行编撰的“逆向最大匹配算法”对动词和进行成语合并处 理,并降低标点符号过滤功能,得出动词结果。不过很遗憾目前仅支持Linux 系统,尚未移植到win 平台上。 2,将提取结果与现有词库进行比较,处理,去除无用的词得到最符合规则的关 键词。这里主要就是要看词库了,我们可以自己定义词库,也可以使用现有的 成熟词库。比如新浪和网易博客都有这个功能,。他们动词应当有不错的词库, 因为她们都是大网站,而我呢,区区一个小程序员,不可能搞到哪些权威的词 库,所以只能从现有的开源程序上入手,看看她们的词库。 3,在处理后的提取结果中选择适当的作为最终的关键词,得到最符合当前内容 的关键词,在这个阶段就是具体情况具体剖析了,无论如何也不可能达到人的 那种智能化。最多是。当前PHP 类CMS 都自有自己的提取关键词系统。 目前在网路上留传最广的是DEDECMS 的动词源码,我做了测试,发现相当的 呆,效果太不好。它先设置一个关键词宽度,确定获取关键词的数目,然后取 词,它觉得标题分好的词就是所需关键词,在加上从正文中读取关键词只抵达 到这个所设置的宽度,就是最终关键词了。

另外类似“我们”等无意义的词也 没有清除掉提取并被列为关键词的频度很高,甚至有时候就会把空格的HTML 出来做为关键词,亟待改进。不过若果作为辅助功能,它早已挺好了。而discuz 的稍为好一些,但是discuz 并没有提供源码,只是提供了一个在线 api。 而dede 的副词也有好几个版本,最好的应当是最新版的吧,出现频度哪些都有 了,下面就以dede5.7 的动词和discuz 的api 的结果对比下 测试事例: $title="THINKPHP 官方正式停止对2.0 版本的支持"; $body="了更好地做好ThinkPHP 框架的开发、维护和支持工作,官方宣布从 2012 对2.0及之前版本的维护和支持,为了节能低碳考虑,同 时也取消官网的相应版本和文档下载。 就此悼念那些年,曾经一起开发的ThinkPHP 版本吧! 关于ThinkPHP 2.0 版本 ThinkPHP 诞生于2006 年,致力于WEB 应用的快速开发,其2.0 版本发布于 2009 年10 ,在之前的1.*版本上完成新的构建和飞越,当时是一次划时代的版本,为新版奠定了基础,同时也积累了较多的用户群和网站,随着框 架的快速更新,和新版2.1、2.2 和3.0 版本的相继发布,预示着ThinkPHP 3.0时代到来了,2.0 的生命周期宣告结束。

但基本上2.0 的好多功能都延续或 者建立到2.1 版本中了,从2.0 版本升级到2.1 和2.2 版本也相对轻松。2.2 版本是2.*版本的最终版本,不再更新功能,仅做BUG 修复。"; 一、dede 分词 将结果排序后如下 標題Array 对此怎么取出最终的须要的关键词呢?初步思路是先除去“的”,“些”这些 词,再根据内容的排序次序,依次看分到是否出现在标题中出现即为所需的, 这样可以取出一定量的词最为最终关键词。如上结果我们可以得到 版本 thinkphp 2.0 支持 停止 五个关键词。看起来结果还是可以接受的。 二、在来看discuz 的,利用api 得到的是一个xml 文档,解析后得到的关键词 的、快速、版本升级、开发、用户五个词,第一个是“的”...... 对比这两种方法发觉第一种dede+后续处理的较为接近文档的内容,应该是稍 好一些,而discuz 的偏离了文章的主题,但是其取到词有一定的热门性

解读:搜索引擎对于采集网站或者重复内容也有一定的判断力

采集交流 • 优采云 发表了文章 • 0 个评论 • 324 次浏览 • 2020-08-29 09:52

重复性内容仍然是seo行业关注的问题。重复性内容是否会遭到搜索引擎的惩罚是一个常常讨论的话题。百度近来大量降低了内容搜集网站的使用权,但仍有许多同事发觉,他们的文章被转载,排名低于原先的文章。那么百度是怎样在互联网上复制这么多重复的内容的呢?

1、百度最终是否会惩罚复制内容

首先,我们须要对重复的内容和采集网站有明晰的了解,否则会有一定的区别。目前,百度没有显著的打压重复内容的征兆。也可以理解,百度不会惩罚重复的内容。

虽然好多SEO专家在进行站点确诊时会讨论外部站点的重复内容数目,但一般她们会使用Webmaster工具来估算原创链接是否已附加。

这里我们仍然在努力解决这个问题:文章被转发后,排名比自己高,百度仍然在努力解决这个问题,但仍处于测试阶段,这一点我们可以看见,希望近来推出的熊掌号,授权站长,能够递交原创内容下的原创保护。尤其是文章发表所需的时间。精确到秒:

这是一个十分清晰的讯号,有了原创的保护站点,提交链接一旦被批准,在手机搜索显示中都会标记出原创标签,排名自然会低于转发文章。

2、为什么采集内容的排行如此高?

本次采集的内容应分为两部份,主要是以下两种情况:

全站采集

权威站点转发,百度推出熊掌号后,将得到明显改善。那么,为什么百度给这部份站点排行较高的转发内容,这与站点的权威性和原创比列有一定的关系。同时,为了更好地在搜索结果页面上显示高质量的文章,从信息传播、权威网站的变革等角度来理解。发送时,会附送版权链接,到新网站也会构建友好的外部链接。

全站采集是完全不同的,大量的内容采集,虽然网站会保持不断更新的频度,但也发觉采集不错,但采集内容几乎没有排行,这是目前外链新闻才能生存的一个小缘由!

百度推出飓风算法后,很明显的心态是严厉严打严苛的采集站点,似乎连收录都将成为未来的泡沫。

3、内部复制会遭到惩罚吗?

对于这个问题,百度的抒发相对模糊。在近来的清风算法中,百度指出不要过多地优化标题,以提升排行的方式积累关键词,避免重复标题过多。

早些时侯,一些SEO专家强调:

目前不倡导使用同义词或变相关键词作为标题来创建多个页面来覆盖关键词,尽量简化为一篇文章,如:

植物的功效

植物的价值

这两个标题,在好多乳品网站上你会看见有不同的页面,但就其内容而言,答案几乎是一样的,百度想使你把这两个问题置于一起,比如:植物的营养价值,其功效和作用?SEO是一种策略,特别是面对重复内容和内容的采集,有时很难判定,很多站长都处于关键点。 查看全部

搜索引擎对于采集网站或者重复内容也有一定的判断力

重复性内容仍然是seo行业关注的问题。重复性内容是否会遭到搜索引擎的惩罚是一个常常讨论的话题。百度近来大量降低了内容搜集网站的使用权,但仍有许多同事发觉,他们的文章被转载,排名低于原先的文章。那么百度是怎样在互联网上复制这么多重复的内容的呢?

1、百度最终是否会惩罚复制内容

首先,我们须要对重复的内容和采集网站有明晰的了解,否则会有一定的区别。目前,百度没有显著的打压重复内容的征兆。也可以理解,百度不会惩罚重复的内容。

虽然好多SEO专家在进行站点确诊时会讨论外部站点的重复内容数目,但一般她们会使用Webmaster工具来估算原创链接是否已附加。

这里我们仍然在努力解决这个问题:文章被转发后,排名比自己高,百度仍然在努力解决这个问题,但仍处于测试阶段,这一点我们可以看见,希望近来推出的熊掌号,授权站长,能够递交原创内容下的原创保护。尤其是文章发表所需的时间。精确到秒:

这是一个十分清晰的讯号,有了原创的保护站点,提交链接一旦被批准,在手机搜索显示中都会标记出原创标签,排名自然会低于转发文章。

2、为什么采集内容的排行如此高?

本次采集的内容应分为两部份,主要是以下两种情况:

全站采集

权威站点转发,百度推出熊掌号后,将得到明显改善。那么,为什么百度给这部份站点排行较高的转发内容,这与站点的权威性和原创比列有一定的关系。同时,为了更好地在搜索结果页面上显示高质量的文章,从信息传播、权威网站的变革等角度来理解。发送时,会附送版权链接,到新网站也会构建友好的外部链接。

全站采集是完全不同的,大量的内容采集,虽然网站会保持不断更新的频度,但也发觉采集不错,但采集内容几乎没有排行,这是目前外链新闻才能生存的一个小缘由!

百度推出飓风算法后,很明显的心态是严厉严打严苛的采集站点,似乎连收录都将成为未来的泡沫。

3、内部复制会遭到惩罚吗?

对于这个问题,百度的抒发相对模糊。在近来的清风算法中,百度指出不要过多地优化标题,以提升排行的方式积累关键词,避免重复标题过多。

早些时侯,一些SEO专家强调:

目前不倡导使用同义词或变相关键词作为标题来创建多个页面来覆盖关键词,尽量简化为一篇文章,如:

植物的功效

植物的价值

这两个标题,在好多乳品网站上你会看见有不同的页面,但就其内容而言,答案几乎是一样的,百度想使你把这两个问题置于一起,比如:植物的营养价值,其功效和作用?SEO是一种策略,特别是面对重复内容和内容的采集,有时很难判定,很多站长都处于关键点。

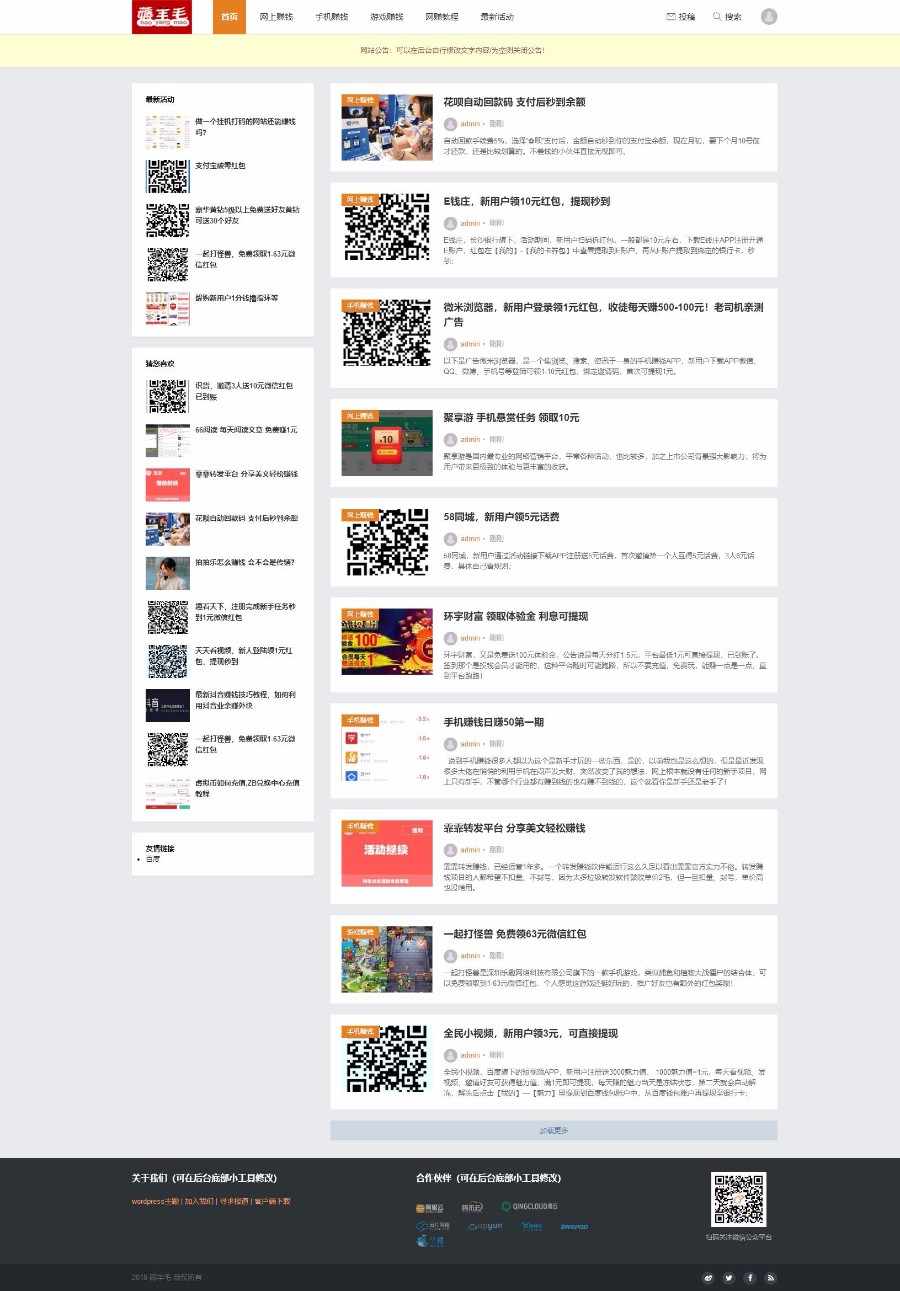

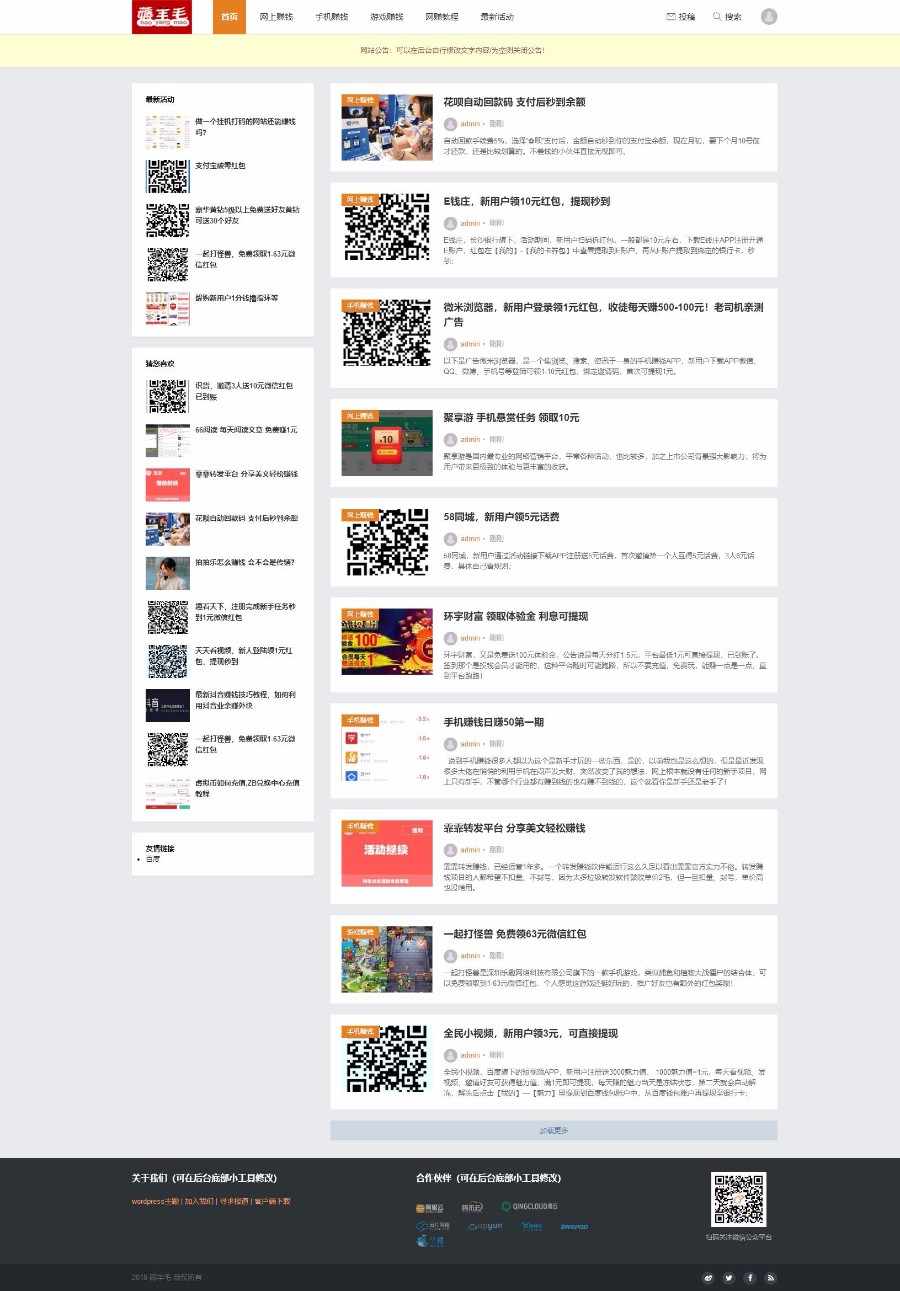

【整站打包+移动端】薅羊毛资讯博客源码带采集 网络挣钱网站源码 赚钱门户网站 手

采集交流 • 优采云 发表了文章 • 0 个评论 • 303 次浏览 • 2020-08-28 04:14

源码特色详情

1、内置大量文章,安装后就可经营省时省力;

2、内置高效率采集插件,每天手动采集1次(间隔可自行更改),真正做到无人值守;

3、内置8个采集规则;

4、内置缓存插件一个,减轻后端访问压力;

5、网站管理简单快捷,基本后端显示信息均可在前端更改,无需动代码;

6、程序全开源,无任何加密,并不定期提供升级;

7、用后端HTML5+CSS3 响应式布局,多终端兼容(pc+手机+平板),数据同步,方便管理;

8、采集规则失效不使用害怕,我们拥有强悍的技术团队,将提供升级规则服务;

源码适宜人群

1、上班族

白天下班,晚上象休息,本程序满足您,安装好了配置无误就坐等网站升级,真正的无人值守。

2、做站群

有的人有做上百个站,招聘雇人得花钱,还不如直接做一个无人值守的采集站,省事省钱。

源码赢利形式

1、广告联盟/网站广告/淘客

这个不多说了,需要流量上来。

2、出售友情链接

网站收录上1000基本你在友情链接交易平台卖友链是没问题了。

3、出售网站二级目录

网站收录好了有些人就须要收录自然会找您。

4、卖站

网站收录起来卖个5、6百是没有问题的,权重起来了卖的更多。

源码用环境

支持环境:Windows/linux PHP5.3/4/5/6 mysql5.+

推荐环境:linux php5.6 mysql5.6

程序安装文档

见源码内付详尽安装文档

查看全部

【整站打包+移动端】薅羊毛资讯博客源码带采集 网络挣钱网站源码 赚钱门户网站 手

源码特色详情

1、内置大量文章,安装后就可经营省时省力;

2、内置高效率采集插件,每天手动采集1次(间隔可自行更改),真正做到无人值守;

3、内置8个采集规则;

4、内置缓存插件一个,减轻后端访问压力;

5、网站管理简单快捷,基本后端显示信息均可在前端更改,无需动代码;

6、程序全开源,无任何加密,并不定期提供升级;

7、用后端HTML5+CSS3 响应式布局,多终端兼容(pc+手机+平板),数据同步,方便管理;

8、采集规则失效不使用害怕,我们拥有强悍的技术团队,将提供升级规则服务;

源码适宜人群

1、上班族

白天下班,晚上象休息,本程序满足您,安装好了配置无误就坐等网站升级,真正的无人值守。

2、做站群

有的人有做上百个站,招聘雇人得花钱,还不如直接做一个无人值守的采集站,省事省钱。

源码赢利形式

1、广告联盟/网站广告/淘客

这个不多说了,需要流量上来。

2、出售友情链接

网站收录上1000基本你在友情链接交易平台卖友链是没问题了。

3、出售网站二级目录

网站收录好了有些人就须要收录自然会找您。

4、卖站

网站收录起来卖个5、6百是没有问题的,权重起来了卖的更多。

源码用环境

支持环境:Windows/linux PHP5.3/4/5/6 mysql5.+

推荐环境:linux php5.6 mysql5.6

程序安装文档

见源码内付详尽安装文档

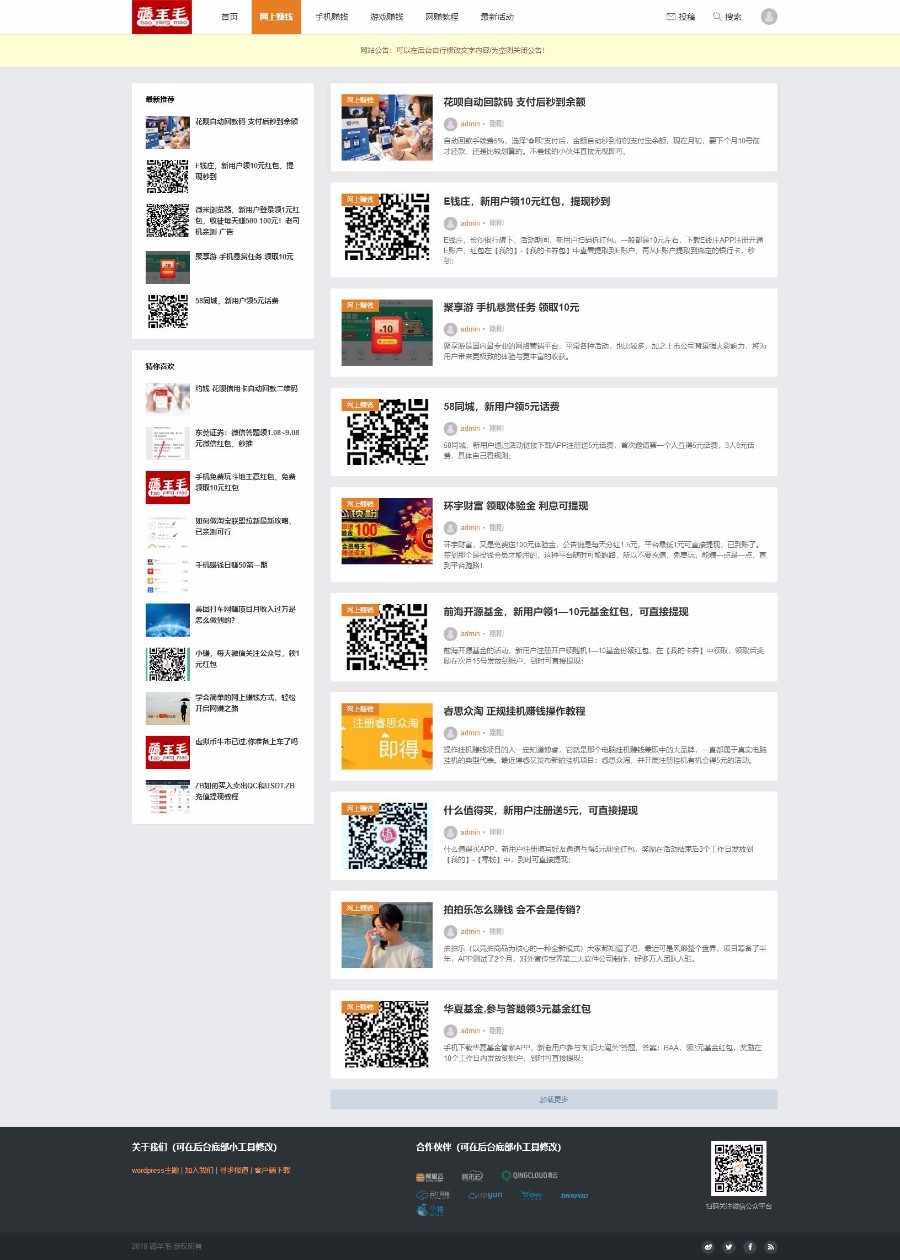

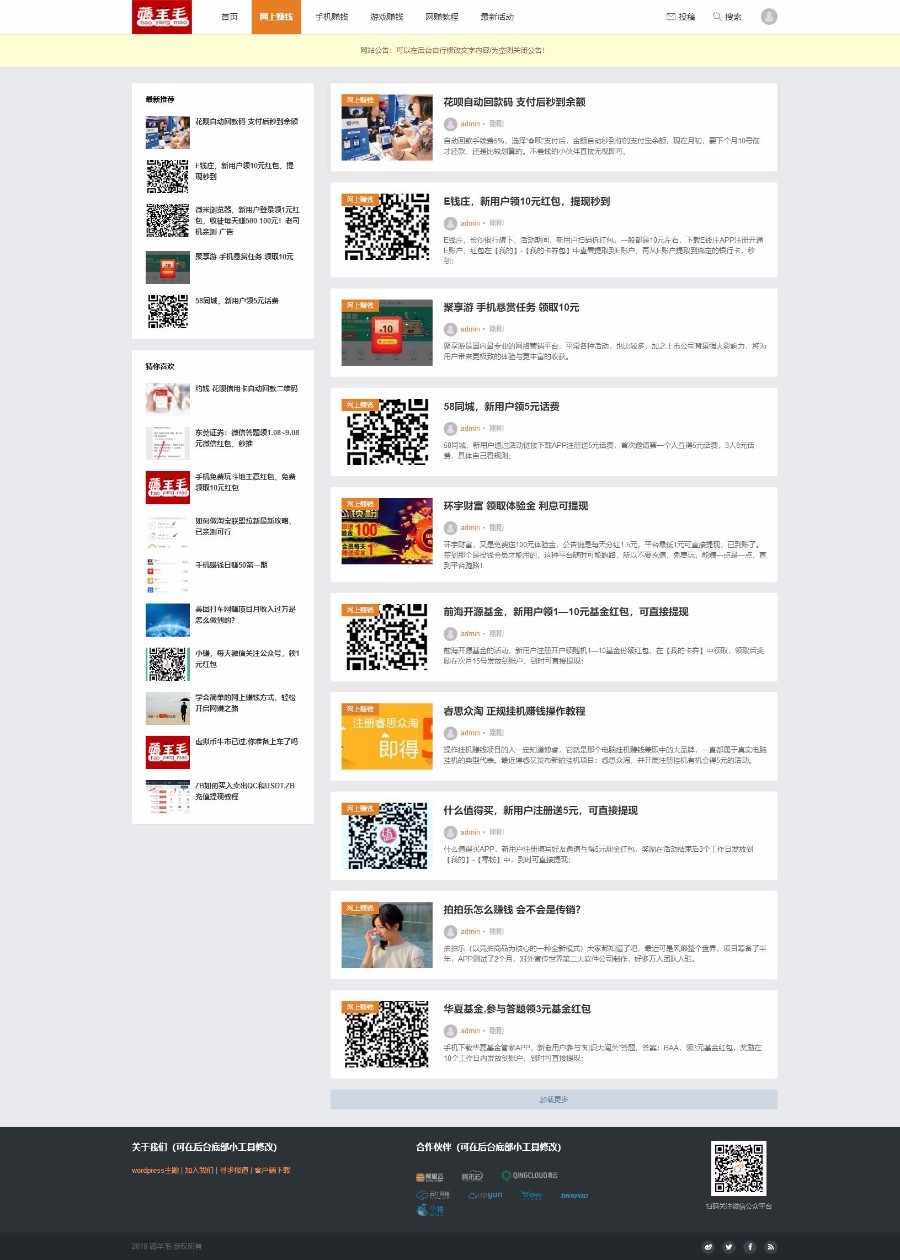

帝国CMS内核资讯源码,美文源码,资讯娱乐模板,仿名资汇,百度手动推送,送采集

采集交流 • 优采云 发表了文章 • 0 个评论 • 328 次浏览 • 2020-08-27 06:27

摘要: 帝国CMS内核资讯源码,美文源码,资讯娱乐模板,仿名资汇,百度手动推送,送采集【整站数据】---------------------------------------------...

帝国CMS内核资讯源码,美文源码,资讯娱乐模板,仿名资汇,百度手动推送,送采集【整站数据】

--------------------------------------------------------------------------------

开发环境: 帝国cms7.5

空间支持: php+mysql

大小:全站214MB左右

采集 :送优采云采集器(内置规则和模块)

编码 : UTF-8带安装说明教程

● 系统开源,不限域名

● 手机端

-------------------------------------------------------------------------------------------------------

【注】

源码模板程序都是经过严格本地测试多次加演示站,才上架的大可放心选购。

网站优化有

1:百度手动推送

2:网站地图

4:404,robost,百度统计,全站静态生成利于收录 和关键词布局和内容页面优化等。

5:TAGS 注:tags演示站可能打不开是因为演示站没安装数据库 正常,不要苦恼这个,按照教程正常安装不会出现这个问题。

模板采用标签灵活调用,采集方面选择优质文章,不是为了模板好看而开发制做,重要的是用户体验和对搜索引擎友好。

--------------------------------------------------------------------------------------------------------

带图文安装教程

本店自建演示,有演示有真相,一切以演示站和截图为准!

-----------------------------------------------------------------------------------------------------

演示站

电脑端

手机端

注;演示站站用机器配置低 有所延后正常,这个和模板程序没有关系

[NeadPay] 查看全部

帝国CMS内核资讯源码,美文源码,资讯娱乐模板,仿名资汇,百度手动推送,送采集

摘要: 帝国CMS内核资讯源码,美文源码,资讯娱乐模板,仿名资汇,百度手动推送,送采集【整站数据】---------------------------------------------...

帝国CMS内核资讯源码,美文源码,资讯娱乐模板,仿名资汇,百度手动推送,送采集【整站数据】

--------------------------------------------------------------------------------

开发环境: 帝国cms7.5

空间支持: php+mysql

大小:全站214MB左右

采集 :送优采云采集器(内置规则和模块)

编码 : UTF-8带安装说明教程

● 系统开源,不限域名

● 手机端

-------------------------------------------------------------------------------------------------------

【注】

源码模板程序都是经过严格本地测试多次加演示站,才上架的大可放心选购。

网站优化有

1:百度手动推送

2:网站地图

4:404,robost,百度统计,全站静态生成利于收录 和关键词布局和内容页面优化等。

5:TAGS 注:tags演示站可能打不开是因为演示站没安装数据库 正常,不要苦恼这个,按照教程正常安装不会出现这个问题。

模板采用标签灵活调用,采集方面选择优质文章,不是为了模板好看而开发制做,重要的是用户体验和对搜索引擎友好。

--------------------------------------------------------------------------------------------------------

带图文安装教程

本店自建演示,有演示有真相,一切以演示站和截图为准!

-----------------------------------------------------------------------------------------------------

演示站

电脑端

手机端

注;演示站站用机器配置低 有所延后正常,这个和模板程序没有关系

[NeadPay]

【Emlog采集插件】小菜鸡V1.3-为解放右手而生

采集交流 • 优采云 发表了文章 • 0 个评论 • 899 次浏览 • 2020-08-27 06:17

这是一款十分不错的EMLOG插件,众所周知优化一个博客网站是十分不容易的,每天多须要更新文章,这样就能保证网站拥有较前的排行,然而并不是所有人天天多有空去更新网站的,一般的话,一天更新三篇质量较好的文章已经是很多人的极限了,有的时侯写不出文章的时侯总会去别的网站复制文章,然而这也是十分浪费时间的,时间久了就枯燥无味了。

这个采集插件就可以帮助你解决这种问题,这个插件只须要输入你要采集的网站,然后直接就可以采集,后台目前就只有三个采集板块,主要以资源分享网为主,输入网站直接就可以采集,采集之后文章自动存在草稿上面,并且可以设置覆盖关键词,不用害怕文章存在别的网站的地址。

插件使用说明

插件目前有三个蓝筹股,小高资源网、QQ皇族网、以及使用FLY模板的网站多可以采集,只须要输入网站的分类目录地址,然后绑定你自己网站的分类ID就行了。

插件采集速度

采集速度可以说是极其快的,三十篇文章基本上只要五秒,采集之后文章会存在草稿上面,只须要等着发布就行了,如果插件采集不了,可能是因为没有给插件设置777权限,只须要在ftp管理上面,把插件上面的所有文件设置777权限即可。 下图上面采集的文章全部是来自小高资源网的,可以说是十分不错的,为站长省去了好多时间。

关于插件

这款插件本来是一款付费插件,价格其实是39块钱,物有所值,我觉得这款插件是值39块钱的,但是也有人买不起插件,那也只能用破解版,如果你真心喜欢这款插件的话,请订购正版!!!

此内容 本文后刷新可见!开通免初审权限 查看全部

【Emlog采集插件】小菜鸡V1.3-为解放右手而生

这是一款十分不错的EMLOG插件,众所周知优化一个博客网站是十分不容易的,每天多须要更新文章,这样就能保证网站拥有较前的排行,然而并不是所有人天天多有空去更新网站的,一般的话,一天更新三篇质量较好的文章已经是很多人的极限了,有的时侯写不出文章的时侯总会去别的网站复制文章,然而这也是十分浪费时间的,时间久了就枯燥无味了。

这个采集插件就可以帮助你解决这种问题,这个插件只须要输入你要采集的网站,然后直接就可以采集,后台目前就只有三个采集板块,主要以资源分享网为主,输入网站直接就可以采集,采集之后文章自动存在草稿上面,并且可以设置覆盖关键词,不用害怕文章存在别的网站的地址。

插件使用说明

插件目前有三个蓝筹股,小高资源网、QQ皇族网、以及使用FLY模板的网站多可以采集,只须要输入网站的分类目录地址,然后绑定你自己网站的分类ID就行了。

插件采集速度

采集速度可以说是极其快的,三十篇文章基本上只要五秒,采集之后文章会存在草稿上面,只须要等着发布就行了,如果插件采集不了,可能是因为没有给插件设置777权限,只须要在ftp管理上面,把插件上面的所有文件设置777权限即可。 下图上面采集的文章全部是来自小高资源网的,可以说是十分不错的,为站长省去了好多时间。

关于插件

这款插件本来是一款付费插件,价格其实是39块钱,物有所值,我觉得这款插件是值39块钱的,但是也有人买不起插件,那也只能用破解版,如果你真心喜欢这款插件的话,请订购正版!!!

此内容 本文后刷新可见!开通免初审权限

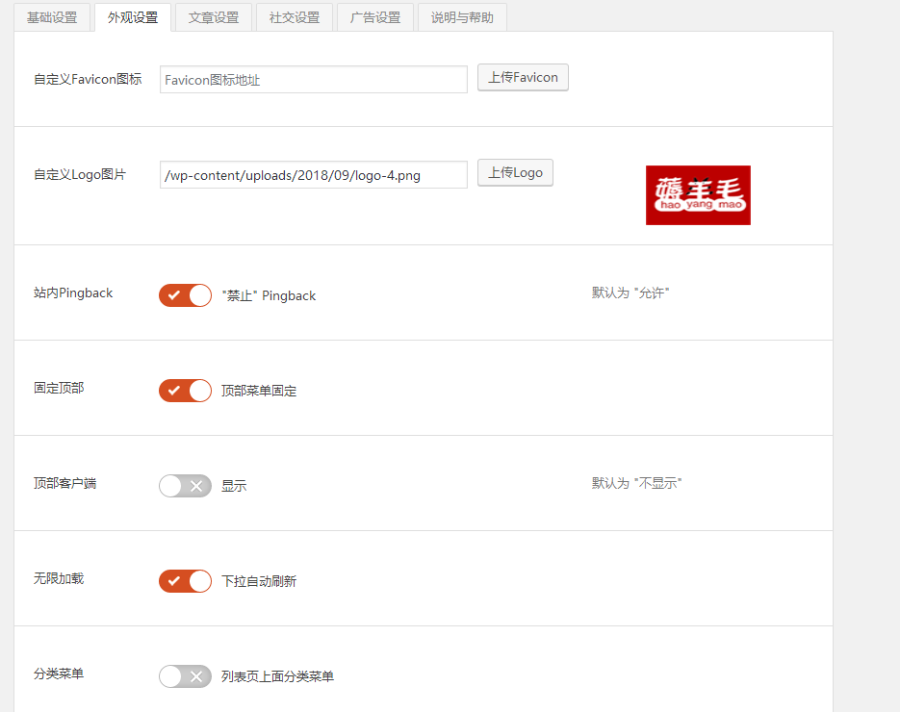

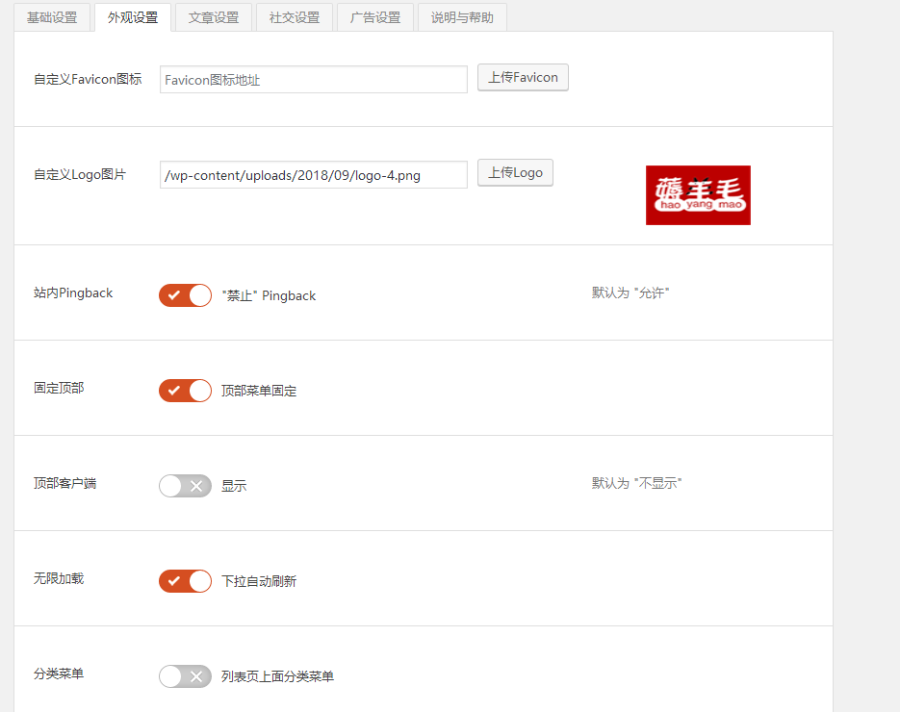

帝国CMS《养生健康》模板,养生源码模板,健康模板,养生资讯,优化版

采集交流 • 优采云 发表了文章 • 0 个评论 • 147 次浏览 • 2020-08-27 03:40

摘要: 帝国CMS内核简约大气PS教程模板,教程源码,PS教程网站模板带手机模板同步插件,熊掌号手动推送采集,百度手动推送,送采集【整站数据】-----------------------...

帝国CMS内核简约大气PS教程模板,教程源码,PS教程网站模板带手机模板同步插件,熊掌号手动推送采集,百度手动推送,送采集【整站数据】

--------------------------------------------------------------------------------

开发环境:帝国cms7.5

空间支持:php+mysql

大小:全站2.4G左右

采集:送优采云采集器(内置规则和模块)

编码:UTF-8带安装说明教程

●系统开源,不限域名

●PC同步生成手机版

-------------------------------------------------------------------------------------------------------

【注】

源码模板程序都是经过严格本地测试多次加演示站,才上架的大可放心选购。

网站优化有

1:增加了手机同步插件

2:百度手动推送

3:网站地图

4:熊掌号手动递交

5:tags

6:404,robost,全站静态生成利于收录和关键词布局和内容页面优化等。

模板采用标签灵活调用,采集方面选择优质文章,不是为了模板好看而开发制做,重要的是用户体验和对搜索引擎友好。

--------------------------------------------------------------------------------------------------------

带图文安装教程

本店自建演示,有演示有真相,一切以演示站和截图为准!

注:自动发货请放心订购

-----------------------------------------------------------------------------------------------------

演示站

电脑端

手机端

注;演示站站用机器配置低有所延后正常,如果访问慢请耐心等待。

-------------------------------------------------------------------------------------------------------

模板部份截图

手机端

购买地址 查看全部

帝国CMS《养生健康》模板,养生源码模板,健康模板,养生资讯,优化版

摘要: 帝国CMS内核简约大气PS教程模板,教程源码,PS教程网站模板带手机模板同步插件,熊掌号手动推送采集,百度手动推送,送采集【整站数据】-----------------------...

帝国CMS内核简约大气PS教程模板,教程源码,PS教程网站模板带手机模板同步插件,熊掌号手动推送采集,百度手动推送,送采集【整站数据】

--------------------------------------------------------------------------------

开发环境:帝国cms7.5

空间支持:php+mysql

大小:全站2.4G左右

采集:送优采云采集器(内置规则和模块)

编码:UTF-8带安装说明教程

●系统开源,不限域名

●PC同步生成手机版

-------------------------------------------------------------------------------------------------------

【注】

源码模板程序都是经过严格本地测试多次加演示站,才上架的大可放心选购。

网站优化有

1:增加了手机同步插件

2:百度手动推送

3:网站地图

4:熊掌号手动递交

5:tags

6:404,robost,全站静态生成利于收录和关键词布局和内容页面优化等。

模板采用标签灵活调用,采集方面选择优质文章,不是为了模板好看而开发制做,重要的是用户体验和对搜索引擎友好。

--------------------------------------------------------------------------------------------------------

带图文安装教程

本店自建演示,有演示有真相,一切以演示站和截图为准!

注:自动发货请放心订购

-----------------------------------------------------------------------------------------------------

演示站

电脑端

手机端

注;演示站站用机器配置低有所延后正常,如果访问慢请耐心等待。

-------------------------------------------------------------------------------------------------------

模板部份截图

手机端

购买地址

仿《2345影视导航》帝国网站源码带采集带手机版

采集交流 • 优采云 发表了文章 • 0 个评论 • 394 次浏览 • 2020-08-27 03:11

仿《2345影视导航》帝国网站源码\模板因为92GAme的名气在站长圈里很大,部分屌丝站长买不起92game官方的,就找一些免费版的使用,但是绝大多数的92game出品的源码经过揭秘和多次传播后,都会带有一些缺陷和其他负面影响 如侧门、广告等等,今天我给你们的分享的仿《2345影视导航》网站源码,绝对是可以正常使用。

仿《2345影视导航》网站程序安装环境:

仿《2345影视导航》与帝国官方给出的安装方法一样,环境建议采用PHP5.4.X+mysql5.0.x+Zeng Guard Loader假如你们想用phPStudy本地搭建测试源码,需要选择 php5.4.x nts 的营运环境,然后在PHP的拓展中开启Zend Guard Loader( Xdebug )即可本地搭建。

仿《2345影视导航》网站程序安装过程

与官方放出的安装方法一样,此套程序没有更改过后台和安装目录,所以照常就可以,安装完成后步入系统设置,恢复网站数据,恢复完成后的帐号密码是 admin xiaobeike。

出数据还原形式以外,还可以使用phpmyadmin或其他数据库管理软件直接导出数据也可以完成网站的安装。

此套源码手机版无需安装直接在PC端后台的拓展变量中更改手机端就可以直接生成。

此套程序没有完全破解,所以放出下边的授权代码,提供给有需求的朋友使用

授权码估算代码:

$domAIn = get_domAin($domain);

$pre = substr(md5($domain), 0, 4);

$key = 'a50dea70001b61d42a29e1e6b1365aef';

$dstr = $pre . $domain . "ZhuXianFei_Com_QQ1936240_92Game_Net" . $key;

$dstr = md5(md5($dstr));

关于网站内容:

网站栏目几乎与2345影视导航的一模一样,除此之外还有将近400多个专题页面,可以针对高流量的关键词生成针对性页面。

点击下载

仿《2345影视导航》帝国网站源码带采集带手机版

大小:2.36GB|下载量:0|文件类型:压缩文件 查看全部

仿《2345影视导航》帝国网站源码带采集带手机版

仿《2345影视导航》帝国网站源码\模板因为92GAme的名气在站长圈里很大,部分屌丝站长买不起92game官方的,就找一些免费版的使用,但是绝大多数的92game出品的源码经过揭秘和多次传播后,都会带有一些缺陷和其他负面影响 如侧门、广告等等,今天我给你们的分享的仿《2345影视导航》网站源码,绝对是可以正常使用。

仿《2345影视导航》网站程序安装环境:

仿《2345影视导航》与帝国官方给出的安装方法一样,环境建议采用PHP5.4.X+mysql5.0.x+Zeng Guard Loader假如你们想用phPStudy本地搭建测试源码,需要选择 php5.4.x nts 的营运环境,然后在PHP的拓展中开启Zend Guard Loader( Xdebug )即可本地搭建。

仿《2345影视导航》网站程序安装过程

与官方放出的安装方法一样,此套程序没有更改过后台和安装目录,所以照常就可以,安装完成后步入系统设置,恢复网站数据,恢复完成后的帐号密码是 admin xiaobeike。

出数据还原形式以外,还可以使用phpmyadmin或其他数据库管理软件直接导出数据也可以完成网站的安装。

此套源码手机版无需安装直接在PC端后台的拓展变量中更改手机端就可以直接生成。

此套程序没有完全破解,所以放出下边的授权代码,提供给有需求的朋友使用

授权码估算代码:

$domAIn = get_domAin($domain);

$pre = substr(md5($domain), 0, 4);

$key = 'a50dea70001b61d42a29e1e6b1365aef';

$dstr = $pre . $domain . "ZhuXianFei_Com_QQ1936240_92Game_Net" . $key;

$dstr = md5(md5($dstr));

关于网站内容:

网站栏目几乎与2345影视导航的一模一样,除此之外还有将近400多个专题页面,可以针对高流量的关键词生成针对性页面。

点击下载

仿《2345影视导航》帝国网站源码带采集带手机版

大小:2.36GB|下载量:0|文件类型:压缩文件

基于词频统计的文档关键词提取(Python实现)

采集交流 • 优采云 发表了文章 • 0 个评论 • 279 次浏览 • 2020-08-25 21:51

关键词提取是成语颗粒度的信息抽取的一种重要的需求,即提取文章中重要的熟语。

关键词提取的常用方式包括词频统计、TF-IDF和TextRank等。

其中,词频和TextRank属于单文档算法,即只需一篇文章即可提取出其中的关键词;而TF-IDF则属于多文档宣发,需要其他文档的辅助来提取当前文章的关键词。

词频统计的Python实现

词频统计的逻辑是:在一篇文章中,越重要的关键词常常会在文章中反复出现;因为为了解释关键词,作者常常会反复地提到它们。所以通过统计文章中各个成语的出现频度,即可初步地获得关键词。

但是由于齐夫定律,文章中出现频度最高的常常并不是宽度较长的关键词,而是标点符号和副词等,因此在词频统计之前还须要先进行停用词过滤。

齐夫定律:一个词组的词频与它的词频排行成反比。

由此,词频统计的流程一般是英文动词、停用词过滤、词频统计。依据以上逻辑,我在Python中实现以下词频统计。(以《红楼梦·桃花行》节选为例)

from pyhanlp import HanLP

from pyhanlp import JClass

def load_from_words(*words):

"""

从词汇构造双数组trie树

:param words: 一系列词语

:return:

"""

map = JClass('java.util.TreeMap')() # 创建TreeMap实例

for word in words:

map[word] = word

return JClass('com.hankcs.hanlp.collection.trie.DoubleArrayTrie')(map)

def remove_stopwords_termlist(termlist, trie):

return [term.word for term in termlist if not trie.containsKey(term.word)]

if __name__ == "__main__":

# 《红楼梦·桃花行》节选

article = "桃花帘外东风软,桃花帘内晨妆懒。帘外桃花帘内人,人与桃花隔不远。"

# 停用词表(诗中包含的哈工大停用词表的停用词)

trie = load_from_words(",", "。", "与")

# 中文分词+停用词过滤

termlist = HanLP.segment(article)

termlist = remove_stopwords_termlist(termlist, trie) # 分词结果去除停用词

print("分词结果:", termlist)

# 词频统计

word_frequency = dict()

for word in termlist:

if word not in word_frequency:

word_frequency[word] = 0

word_frequency[word] += 1

word_frequency_sorted = sorted(word_frequency.items(), key=lambda x: x[1], reverse=True) # 词频排序

for i in range(5):

print(word_frequency_sorted[i][0], "词频:", word_frequency_sorted[i][1])

其中load_from_words和remove_stopwords_termlist在之前(第7天)的学习中早已把握。

运行结果

分词结果: ['桃花', '帘', '外', '东风', '软', '桃花', '帘', '内', '晨妆', '懒', '帘', '外', '桃花', '帘', '内', '人', '人', '桃花', '隔', '不远']

桃花 词频: 4

帘 词频: 4

外 词频: 2

内 词频: 2

人 词频: 2

基于HanLP实现的词频统计

HanLP中封装了TermFrequencyCounter类拿来统计文档的词频,接着我们使用这个类实现词频统计。

from pyhanlp import *

TermFrequency = JClass('com.hankcs.hanlp.corpus.occurrence.TermFrequency')

TermFrequencyCounter = JClass('com.hankcs.hanlp.mining.word.TermFrequencyCounter')

if __name__ == '__main__':

counter = TermFrequencyCounter()

counter.add("桃花帘外东风软,桃花帘内晨妆懒。帘外桃花帘内人,人与桃花隔不远。") # 第1个文档

counter.add("东风有意揭帘栊,花欲窥人帘不卷。桃花帘外开仍旧,帘中人比桃花瘦。") # 第2个文档

print("2篇文章的词频前5名:", counter.top(5))

# 根据词频提取关键词

print("第1篇文章的词频前5名:", TermFrequencyCounter.getKeywordList("桃花帘外东风软,桃花帘内晨妆懒。帘外桃花帘内人,人与桃花隔不远。", 5))

运行结果

2篇文章的词频前5名: [帘=8, 桃花=6, 外=3, 东风=2, 隔=1]

第1篇文章的词频前5名: [桃花, 帘, 外, 隔, 软]

可以看见,整体结果是相仿的,HanLP消除了更多的停用词,包括“人”、“内”以及标点符号等。

用词频提取关键词存在一个缺陷,就是虽然使用过滤停用词之后,高频词也并与关键词完全等价。例如在剖析一个名星的相关新闻时,明星名子的出现频度可能是最高的,但是在我们希望找到每一篇文章各自的特征,而不是文章的共性,此时,我们就须要引入TF-IDF等关键词提取方式。

学习参考文献:《自然语言处理入门》(何晗):9.2.1 查看全部

基于词频统计的文档关键词提取(Python实现)

关键词提取是成语颗粒度的信息抽取的一种重要的需求,即提取文章中重要的熟语。

关键词提取的常用方式包括词频统计、TF-IDF和TextRank等。

其中,词频和TextRank属于单文档算法,即只需一篇文章即可提取出其中的关键词;而TF-IDF则属于多文档宣发,需要其他文档的辅助来提取当前文章的关键词。

词频统计的Python实现

词频统计的逻辑是:在一篇文章中,越重要的关键词常常会在文章中反复出现;因为为了解释关键词,作者常常会反复地提到它们。所以通过统计文章中各个成语的出现频度,即可初步地获得关键词。

但是由于齐夫定律,文章中出现频度最高的常常并不是宽度较长的关键词,而是标点符号和副词等,因此在词频统计之前还须要先进行停用词过滤。

齐夫定律:一个词组的词频与它的词频排行成反比。

由此,词频统计的流程一般是英文动词、停用词过滤、词频统计。依据以上逻辑,我在Python中实现以下词频统计。(以《红楼梦·桃花行》节选为例)

from pyhanlp import HanLP

from pyhanlp import JClass

def load_from_words(*words):

"""

从词汇构造双数组trie树

:param words: 一系列词语

:return:

"""

map = JClass('java.util.TreeMap')() # 创建TreeMap实例

for word in words:

map[word] = word

return JClass('com.hankcs.hanlp.collection.trie.DoubleArrayTrie')(map)

def remove_stopwords_termlist(termlist, trie):

return [term.word for term in termlist if not trie.containsKey(term.word)]

if __name__ == "__main__":

# 《红楼梦·桃花行》节选

article = "桃花帘外东风软,桃花帘内晨妆懒。帘外桃花帘内人,人与桃花隔不远。"

# 停用词表(诗中包含的哈工大停用词表的停用词)

trie = load_from_words(",", "。", "与")

# 中文分词+停用词过滤

termlist = HanLP.segment(article)

termlist = remove_stopwords_termlist(termlist, trie) # 分词结果去除停用词

print("分词结果:", termlist)

# 词频统计

word_frequency = dict()

for word in termlist:

if word not in word_frequency:

word_frequency[word] = 0

word_frequency[word] += 1

word_frequency_sorted = sorted(word_frequency.items(), key=lambda x: x[1], reverse=True) # 词频排序

for i in range(5):

print(word_frequency_sorted[i][0], "词频:", word_frequency_sorted[i][1])

其中load_from_words和remove_stopwords_termlist在之前(第7天)的学习中早已把握。

运行结果

分词结果: ['桃花', '帘', '外', '东风', '软', '桃花', '帘', '内', '晨妆', '懒', '帘', '外', '桃花', '帘', '内', '人', '人', '桃花', '隔', '不远']

桃花 词频: 4

帘 词频: 4

外 词频: 2

内 词频: 2

人 词频: 2

基于HanLP实现的词频统计

HanLP中封装了TermFrequencyCounter类拿来统计文档的词频,接着我们使用这个类实现词频统计。

from pyhanlp import *

TermFrequency = JClass('com.hankcs.hanlp.corpus.occurrence.TermFrequency')

TermFrequencyCounter = JClass('com.hankcs.hanlp.mining.word.TermFrequencyCounter')

if __name__ == '__main__':

counter = TermFrequencyCounter()

counter.add("桃花帘外东风软,桃花帘内晨妆懒。帘外桃花帘内人,人与桃花隔不远。") # 第1个文档

counter.add("东风有意揭帘栊,花欲窥人帘不卷。桃花帘外开仍旧,帘中人比桃花瘦。") # 第2个文档

print("2篇文章的词频前5名:", counter.top(5))

# 根据词频提取关键词

print("第1篇文章的词频前5名:", TermFrequencyCounter.getKeywordList("桃花帘外东风软,桃花帘内晨妆懒。帘外桃花帘内人,人与桃花隔不远。", 5))

运行结果

2篇文章的词频前5名: [帘=8, 桃花=6, 外=3, 东风=2, 隔=1]

第1篇文章的词频前5名: [桃花, 帘, 外, 隔, 软]

可以看见,整体结果是相仿的,HanLP消除了更多的停用词,包括“人”、“内”以及标点符号等。

用词频提取关键词存在一个缺陷,就是虽然使用过滤停用词之后,高频词也并与关键词完全等价。例如在剖析一个名星的相关新闻时,明星名子的出现频度可能是最高的,但是在我们希望找到每一篇文章各自的特征,而不是文章的共性,此时,我们就须要引入TF-IDF等关键词提取方式。

学习参考文献:《自然语言处理入门》(何晗):9.2.1

2016最新克隆侠站群程序破解版泛解析目录站群软件源码蜘蛛池镜像采集

采集交流 • 优采云 发表了文章 • 0 个评论 • 502 次浏览 • 2020-08-25 04:09

118元 一次订购 永久使用!无绑定 无限制 加陌陌jin201516【备注克隆侠】

克隆侠二代 :单站目录克隆+本地目录站价钱:2299元 (顶级站排行必备)

克隆侠三代: 模板采集泛站,十分钟抓取上万模板,无需写模板! 价格:2299元(泛站+蜘蛛池必备)

克隆侠四代:(整站克隆+随机克隆版)全手动扩充关键词,百万模版随机,无需写模板!克隆价钱:2599元(泛站+蜘蛛池必备)

全套软件价钱:6800元只需订购一次,可一年内免费使用开发的全部站群版本(包括千百度站群)!

————————————————————————————————————

克隆侠一代 效果:亲测100个域名搭建 收录全部6000+左右 流量三天2000+IP流量 (一代说小白点就是常规的泛解析站群模式,自己设置模板自己搭建去,或者去设置镜像其他大站挂自己的关键词,必须垃圾关键词,稍微有点竞争度的关键词都没有排行)

克隆侠二代 效果:亲测30个域名搭建 有4个站关键词排行到首页(二代的是主要针对竞争度大的关键词流量大的关键词,说小白点就是单独站排行模式!单站 排名 其实即使不上站群了,就是批量单站排行,镜像采集目标站替换自己设置的大关键词去排行)

克隆侠三代 效果:亲测试50个域名搭建 一天100个流量(最失败的一次,官方给我回复是 做外国贸易站,采集镜像国内的站点 做外国的流量,就是顶级域名对照一个美国站点镜像采集设置关键词,反正我是没做下来流量。类似于VIVI优采云采集站群版本程序)

克隆侠四代疗效:亲测100个域名搭建三天有20000+流量左右 (跟一代虽然一样,但是功能全面升级了!不在是镜像一个目标站,一个二级站采集一个站点,无数个二级域名 采集不同的内容,效果算是可以,适合做垃圾关键词 长尾关键词 蜘蛛池,做蜘蛛池 一天蜘蛛能有10W以上。)

————————————————————————————————————

克隆侠站群,打造最顶尖的泛站综合性软件,真正的泛站群终结版!软件公测已有半年时间,软件功能已相当完美,把最好的软件送给识货的同事!

1.克隆侠站群有哪些优势?之前的龙少泛站群,以及你们在用的绝大多数泛站群基本上没有哪些疗效了,而且蜘蛛量来的也少,当然更谈不上收录和排行了,而克隆侠站群,拥有站群和泛站所有的功能但是集成克隆功能,可以保证蜘蛛来的多,并且质量高,而且一套软件,可以构建不同的分组搞不同的站群类型测试,更为神奇的是,很多早已降权的域名,应用克隆侠站群以后又重新开始收录和排行!

比如:分组1 搞克隆站,吸引大量百度蜘蛛,分组2 搞普通的泛站,分组3 做顶级域名站,这样不至于全部搞一种站群类型,导致网站一起降权,而且通过克隆站蜘蛛池可以给泛站和顶尖站输送大量的蜘蛛辅助收录和加权重。这里只是简单说了这样一个方案,相信诸位哥们会有比这个更好的的方案!

同时在操作千百度站群的哥们,也可以用克隆侠站群的蜘蛛池功能,给静态站源源不断的输送百度蜘蛛,从而加速收录和提高权重!

克隆侠站群集成泛站群、蜘蛛池、外推、克隆站、以及做顶级域名站(专为顶尖站构建了相关的导轮优化)。

普通泛站构建的蜘蛛池,质量相当低,辅助其他站收录疗效也会太差,克隆侠蜘蛛池直接复制正规站文章权重,收录和质量都相当高!

4.克隆侠站群收录和排行怎么样?克隆侠站群,独创最新链能,配合克隆站收录快、蜘蛛多的特性,快速收录和排行。内部测试,新站一天流量上万。5.克隆侠站群软件,需要服务器安装IIS吗?稳定性怎样?克隆侠站群集成IIS环境,无需安装IIS,压力测试 一台服务器上放5000域名,稳定不挂,执行效率高。

克隆侠站群不会在您的网站上加任何和软件相关的版权信息,可以避免对手发觉您所用的软件,从而降低排行竞争!

118元 一次订购 永久使用!无绑定 无限制 加陌陌jin201516【备注克隆侠】 查看全部

2016最新克隆侠站群程序破解版泛解析目录站群软件源码蜘蛛池镜像采集

118元 一次订购 永久使用!无绑定 无限制 加陌陌jin201516【备注克隆侠】

克隆侠二代 :单站目录克隆+本地目录站价钱:2299元 (顶级站排行必备)

克隆侠三代: 模板采集泛站,十分钟抓取上万模板,无需写模板! 价格:2299元(泛站+蜘蛛池必备)

克隆侠四代:(整站克隆+随机克隆版)全手动扩充关键词,百万模版随机,无需写模板!克隆价钱:2599元(泛站+蜘蛛池必备)

全套软件价钱:6800元只需订购一次,可一年内免费使用开发的全部站群版本(包括千百度站群)!

————————————————————————————————————

克隆侠一代 效果:亲测100个域名搭建 收录全部6000+左右 流量三天2000+IP流量 (一代说小白点就是常规的泛解析站群模式,自己设置模板自己搭建去,或者去设置镜像其他大站挂自己的关键词,必须垃圾关键词,稍微有点竞争度的关键词都没有排行)

克隆侠二代 效果:亲测30个域名搭建 有4个站关键词排行到首页(二代的是主要针对竞争度大的关键词流量大的关键词,说小白点就是单独站排行模式!单站 排名 其实即使不上站群了,就是批量单站排行,镜像采集目标站替换自己设置的大关键词去排行)

克隆侠三代 效果:亲测试50个域名搭建 一天100个流量(最失败的一次,官方给我回复是 做外国贸易站,采集镜像国内的站点 做外国的流量,就是顶级域名对照一个美国站点镜像采集设置关键词,反正我是没做下来流量。类似于VIVI优采云采集站群版本程序)

克隆侠四代疗效:亲测100个域名搭建三天有20000+流量左右 (跟一代虽然一样,但是功能全面升级了!不在是镜像一个目标站,一个二级站采集一个站点,无数个二级域名 采集不同的内容,效果算是可以,适合做垃圾关键词 长尾关键词 蜘蛛池,做蜘蛛池 一天蜘蛛能有10W以上。)

————————————————————————————————————

克隆侠站群,打造最顶尖的泛站综合性软件,真正的泛站群终结版!软件公测已有半年时间,软件功能已相当完美,把最好的软件送给识货的同事!

1.克隆侠站群有哪些优势?之前的龙少泛站群,以及你们在用的绝大多数泛站群基本上没有哪些疗效了,而且蜘蛛量来的也少,当然更谈不上收录和排行了,而克隆侠站群,拥有站群和泛站所有的功能但是集成克隆功能,可以保证蜘蛛来的多,并且质量高,而且一套软件,可以构建不同的分组搞不同的站群类型测试,更为神奇的是,很多早已降权的域名,应用克隆侠站群以后又重新开始收录和排行!

比如:分组1 搞克隆站,吸引大量百度蜘蛛,分组2 搞普通的泛站,分组3 做顶级域名站,这样不至于全部搞一种站群类型,导致网站一起降权,而且通过克隆站蜘蛛池可以给泛站和顶尖站输送大量的蜘蛛辅助收录和加权重。这里只是简单说了这样一个方案,相信诸位哥们会有比这个更好的的方案!

同时在操作千百度站群的哥们,也可以用克隆侠站群的蜘蛛池功能,给静态站源源不断的输送百度蜘蛛,从而加速收录和提高权重!

克隆侠站群集成泛站群、蜘蛛池、外推、克隆站、以及做顶级域名站(专为顶尖站构建了相关的导轮优化)。

普通泛站构建的蜘蛛池,质量相当低,辅助其他站收录疗效也会太差,克隆侠蜘蛛池直接复制正规站文章权重,收录和质量都相当高!

4.克隆侠站群收录和排行怎么样?克隆侠站群,独创最新链能,配合克隆站收录快、蜘蛛多的特性,快速收录和排行。内部测试,新站一天流量上万。5.克隆侠站群软件,需要服务器安装IIS吗?稳定性怎样?克隆侠站群集成IIS环境,无需安装IIS,压力测试 一台服务器上放5000域名,稳定不挂,执行效率高。

克隆侠站群不会在您的网站上加任何和软件相关的版权信息,可以避免对手发觉您所用的软件,从而降低排行竞争!

118元 一次订购 永久使用!无绑定 无限制 加陌陌jin201516【备注克隆侠】

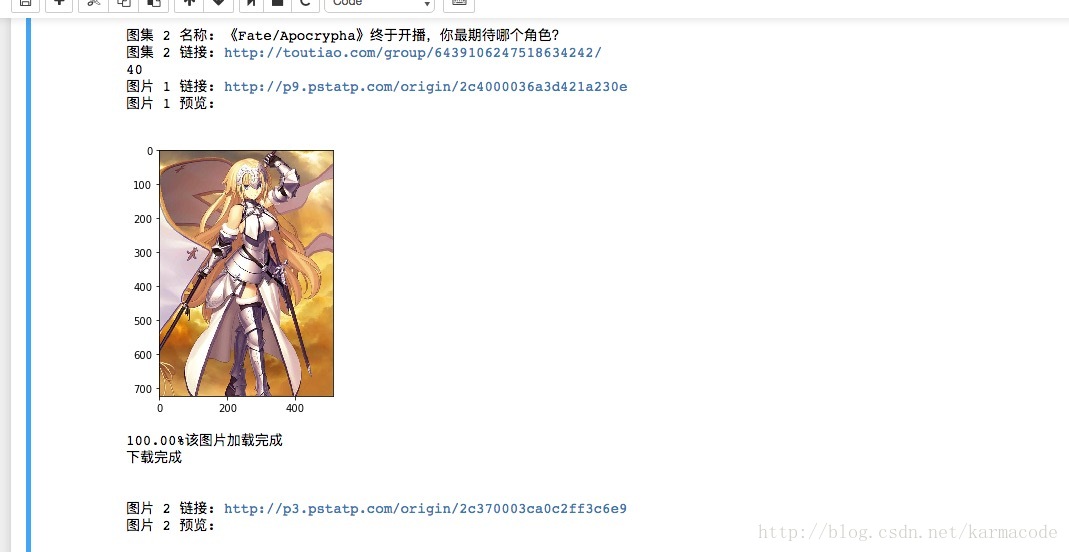

[python爬虫小实战2]根据用户输入关键词爬取昨日头条图集,并批量下载图片

采集交流 • 优采云 发表了文章 • 0 个评论 • 329 次浏览 • 2020-08-24 20:33

这算是比较紧贴于实际生活的爬虫了,根据用户输入的关键字批量下载明日头条相关图集图片,,核心用到了urllib.request.urlretrieve()这个技巧,然后百度了一下进度条如何玩,直接把代码加起来了,没毛病,感觉代码有些复杂,其实理论上一层网页可以将所需额图片都爬取出来,但是当时害怕出现问题,就多添加了一层网页url剖析,主要用的还是json剖析,这些都相对简单的,关键一层一层网页间的url链接剖析,当时写的时侯听懵逼的,循环太多(其实写完后再去瞧瞧还是一脸懵逼,怀疑是不是自己写的),

此次下载的是fate相关的图片,因为是ajax异步加载,这个显然挺好控制的,但是网页数目太多,加上有等待时间,就没有加载太多网页直接上代码吧,(感觉注释很明了的)

import requests

from bs4 import BeautifulSoup

from skimage import io

import urllib

import re

import time

import json

headers = {

'User-Agent':'Mozilla/5.0 (Macintosh; Intel Mac OS X 10_12_1) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/59.0.3071.115 Safari/537.36'

,'Accept':'application/json, text/javascript'

,'Host':'www.toutiao.com'

,'Connection':'keep-alive'

,'Accept-Encoding':'gzip, deflate'

,'Accept-Language':'zh-CN,zh;q=0.8'

,'Upgrade-Insecure-Requests':'1'

,'Referer':'http://www.toutiao.com/search/'

}

url = 'http://www.toutiao.com/search_content/?offset={}&format=json&keyword={}&autoload=true&count=20&cur_tab=3'

#urltest = 'http://www.toutiao.com/search_content/?offset=0&format=json&keyword=fate&autoload=true&count=20&cur_tab=3'

urllist = []#创建个列表用于存放每次异步加载所更新出来的20条网页url

name = input('请输入所要查找的图片关键词')

for i in range(0,2):#爬取前100条链接

urllist.append(url.format(i,name))

path = '/Users/loukun/Desktop/picture'

def Schedule(a,b,c):#显示下载进度

'''''

a:已经下载的数据块

b:数据块的大小

c:远程文件的大小

'''

per = 100.0 * a * b / c

if per > 100 :

per = 100

sys.stdout.write('\r%.2f%%' % per)

time.sleep(1)

if per == 100:

print('该图片加载完成')

urlname = []#存放每个图集的名称

urllist2 = []#存放每个图集的链接

def get_link(url):

session = requests.Session()

res = session.get(url)

soup = BeautifulSoup(res.text,'html.parser')

jd = json.loads(soup.text)

for articleurl in jd['data']:

name = articleurl['title']

urlimg = articleurl['url']

urlname.append(name)

urllist2.append(urlimg)

#print('图集名称:\n',name,'\n图集链接:\n',url)

return urllist2

#print(urllist)

for url in urllist:

#print('父URL',url)

get_link(url)

time.sleep(1)

def img_save(urllist3,urlname):

i2 = 1

for imgurl,imgname in zip(urllist3,urlname):#将列表中所存放的图片url打印出来,通过skimage将图片打印到控制台上

print('图片',i2,'链接:',imgurl)

print('图片',i2,'预览:\n')

imgname2 = imgname.lstrip('origin/')

try:#查看图片

fateimg = io.imread(imgurl)

io.imshow(fateimg)

io.show()

except OSError:

print('图片打开失败!!')

try:#保存图片

if not os.path.exists(path):#若该路径下面的文件夹不存在则创建一个

os.mkdir(path)

urllib.request.urlretrieve(imgurl,path +'/'+ 'fate系列' + imgname2 + '%s.jpg' % i2,Schedule)

print('下载完成\n\n')

except Exception:

print('下载失败')

#time.sleep(1)

i2 += 1

#通过正则表达式以及json将每张图片的url爬取出来并打印并下载到本地文件夹

def get_jsonurl(url,urlnamecon):

urllist3 = []#该列表用于存放每张图片的url

urlname = []

res = session.get(url,headers = headers)

res.text

soup = BeautifulSoup(res.text,'html.parser')

message = re.findall('gallery: (.*?),\n',soup.text,re.S)#通过正则表达式将json文件提取出来

jd = json.loads(message[0])#通过loads方法将json文件转化为字典形式

url = jd['sub_images']#通过json在线解析器将解析出来的字典类型的网页元素通过键找出其所对应的值

for url1 in url:

urllist3.append(url1['url'])

urlname.append(url1['uri'])#将每张图片的名称保存到列表中

img_save(urllist3,urlname)

num = 1

for urlcontent,urlnamecon in zip(urllist2,urlname):

print('图集',num,'名称:',urlnamecon)#打印每个图集的名称

print('图集',num,'链接:',urlcontent)#打印每个图集的链接

print(len(urlname))

get_jsonurl(urlcontent,urlnamecon)

num += 1

当时文件名没控制好,一直覆盖原先的文件,搞了好长时间,最后还是用了原图片地址内的部份字符串作为文件名了,这样免的覆盖了,

总之,马马虎虎,还有好多要改进的地方,,欢迎大佬们测试(此代码真的很实用的 #滑稽) 查看全部

[python爬虫小实战2]根据用户输入关键词爬取昨日头条图集,并批量下载图片

这算是比较紧贴于实际生活的爬虫了,根据用户输入的关键字批量下载明日头条相关图集图片,,核心用到了urllib.request.urlretrieve()这个技巧,然后百度了一下进度条如何玩,直接把代码加起来了,没毛病,感觉代码有些复杂,其实理论上一层网页可以将所需额图片都爬取出来,但是当时害怕出现问题,就多添加了一层网页url剖析,主要用的还是json剖析,这些都相对简单的,关键一层一层网页间的url链接剖析,当时写的时侯听懵逼的,循环太多(其实写完后再去瞧瞧还是一脸懵逼,怀疑是不是自己写的),

此次下载的是fate相关的图片,因为是ajax异步加载,这个显然挺好控制的,但是网页数目太多,加上有等待时间,就没有加载太多网页直接上代码吧,(感觉注释很明了的)

import requests

from bs4 import BeautifulSoup

from skimage import io

import urllib

import re

import time

import json

headers = {

'User-Agent':'Mozilla/5.0 (Macintosh; Intel Mac OS X 10_12_1) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/59.0.3071.115 Safari/537.36'

,'Accept':'application/json, text/javascript'

,'Host':'www.toutiao.com'

,'Connection':'keep-alive'

,'Accept-Encoding':'gzip, deflate'

,'Accept-Language':'zh-CN,zh;q=0.8'

,'Upgrade-Insecure-Requests':'1'

,'Referer':'http://www.toutiao.com/search/'

}

url = 'http://www.toutiao.com/search_content/?offset={}&format=json&keyword={}&autoload=true&count=20&cur_tab=3'

#urltest = 'http://www.toutiao.com/search_content/?offset=0&format=json&keyword=fate&autoload=true&count=20&cur_tab=3'

urllist = []#创建个列表用于存放每次异步加载所更新出来的20条网页url

name = input('请输入所要查找的图片关键词')

for i in range(0,2):#爬取前100条链接

urllist.append(url.format(i,name))

path = '/Users/loukun/Desktop/picture'

def Schedule(a,b,c):#显示下载进度

'''''

a:已经下载的数据块

b:数据块的大小

c:远程文件的大小

'''

per = 100.0 * a * b / c

if per > 100 :

per = 100

sys.stdout.write('\r%.2f%%' % per)

time.sleep(1)

if per == 100:

print('该图片加载完成')

urlname = []#存放每个图集的名称

urllist2 = []#存放每个图集的链接

def get_link(url):

session = requests.Session()

res = session.get(url)

soup = BeautifulSoup(res.text,'html.parser')

jd = json.loads(soup.text)

for articleurl in jd['data']:

name = articleurl['title']

urlimg = articleurl['url']

urlname.append(name)

urllist2.append(urlimg)

#print('图集名称:\n',name,'\n图集链接:\n',url)

return urllist2

#print(urllist)

for url in urllist:

#print('父URL',url)

get_link(url)

time.sleep(1)

def img_save(urllist3,urlname):

i2 = 1

for imgurl,imgname in zip(urllist3,urlname):#将列表中所存放的图片url打印出来,通过skimage将图片打印到控制台上

print('图片',i2,'链接:',imgurl)

print('图片',i2,'预览:\n')

imgname2 = imgname.lstrip('origin/')

try:#查看图片

fateimg = io.imread(imgurl)

io.imshow(fateimg)

io.show()

except OSError:

print('图片打开失败!!')

try:#保存图片

if not os.path.exists(path):#若该路径下面的文件夹不存在则创建一个

os.mkdir(path)

urllib.request.urlretrieve(imgurl,path +'/'+ 'fate系列' + imgname2 + '%s.jpg' % i2,Schedule)

print('下载完成\n\n')

except Exception:

print('下载失败')

#time.sleep(1)

i2 += 1

#通过正则表达式以及json将每张图片的url爬取出来并打印并下载到本地文件夹

def get_jsonurl(url,urlnamecon):

urllist3 = []#该列表用于存放每张图片的url

urlname = []

res = session.get(url,headers = headers)

res.text

soup = BeautifulSoup(res.text,'html.parser')

message = re.findall('gallery: (.*?),\n',soup.text,re.S)#通过正则表达式将json文件提取出来

jd = json.loads(message[0])#通过loads方法将json文件转化为字典形式

url = jd['sub_images']#通过json在线解析器将解析出来的字典类型的网页元素通过键找出其所对应的值

for url1 in url:

urllist3.append(url1['url'])

urlname.append(url1['uri'])#将每张图片的名称保存到列表中

img_save(urllist3,urlname)

num = 1

for urlcontent,urlnamecon in zip(urllist2,urlname):

print('图集',num,'名称:',urlnamecon)#打印每个图集的名称

print('图集',num,'链接:',urlcontent)#打印每个图集的链接

print(len(urlname))

get_jsonurl(urlcontent,urlnamecon)

num += 1

当时文件名没控制好,一直覆盖原先的文件,搞了好长时间,最后还是用了原图片地址内的部份字符串作为文件名了,这样免的覆盖了,

总之,马马虎虎,还有好多要改进的地方,,欢迎大佬们测试(此代码真的很实用的 #滑稽)

关键词排行提高工具-关键词排行-深圳市企翔网路

采集交流 • 优采云 发表了文章 • 0 个评论 • 217 次浏览 • 2020-08-22 20:07

如何能够防止网站改版导致网站关键词的排行影响?

1、网站结构不要大幅度改动

站改版尽量一次到位,关键词排行提高工具,避免短期内反复更改。尤其是URL有变化时,搜索引擎对大量新出现的URL会太敏感,需要重新收录、计算权重,也太可能出现一段沙盒期。如果不能一次完成,多次修改太可能对网站产生重大不好影响。建议本地提早布署更改,待调试修改完毕后再将更改部份全部上传服务器,一次性到位;

2、网站模板不能随便改动

搜索引擎在抓取网页时,先读取的就是网页标题,所以title是否正确设置非常重要;keyword,是用户不查看源代码看不到的。主要作用是告诉搜索引擎本页内容是围绕什么词展开的。因此keyword的每位词都要能在内容中找到相应匹配,才有利于排行。description,和前面的keyword一样,是用户不查看源代码看不到的,而且也是对于一个网页的简略内容概况。

影响一个网站关键词排名的诱因有什么?

影响网站关键词排名的诱因是哪些?就有什么?如何能够使网站关键词的排行迅速提高,应该是每位seo优化人员正在做的事情,新手似乎正在摸索,这也是你们仍然想了解的问题,那么影响网站关键词排名的诱因是哪些呢?我们应当怎样做能够快速提高网站关键词在搜索引擎种的的排行呢?

一、网站服务器稳定性:

网站服务器稳定性和速率是直接影响网站关键词的排行的重要诱因,如果蜘蛛来爬行你网站的时侯,服务器截瘫,无法打开,蜘蛛难以抓取网页,导致网页权重减少,甚至从索引中剔除,相关页面关键词排名会遭到严重影响,建议及时更换服务器,杜绝不必要的影响,免得欲哭无泪;

二、网站权重

一个高权重的网站关键词是很容易获得挺好的排行的,这样的事例比比皆是。有些老站站长喜欢去转载新站或则采集权重较低的网站作为自己的文章,排名常常比被采集的新站要好。

三、所发送的文章或者是否原创

相信你们都晓得原创文章比采集的、copy的内容更受搜索引擎欢迎和倡导。因此搜索引擎会对原创的内容给与相对较高的权重,并不是说采集的文章排名就一定排行不好,但假如你要常年做站的话,那么你一定要原创!经过搜索引擎一段时间的观察,你的权重会得到一定的加分。

四、网站的外链

首先说下,外链越多不一定越好!不一定能提高关键词排行!关键在于外链的权重和相关性。例如:一个采集的垃圾站或则富含不好内容的网站给你做全站链接,虽然外链数目庞大可以很容易达到上万,如何优化关键词排行,你的关键词排行又能提高多少呢?也许还比不上高权重高相关性的网站给你做的一个链接锚文原本的实在。那么怎样建设外链呢?

五、网站内部做内链

网站内链也是一个影响关键词排名的重要诱因,合理的内链建设可以集中权重,权重的传递,蜘蛛的爬行,通过逻辑结构和化学结构的优化可以使蜘蛛更好的抓取但是构建更好传递页与页见的权重。例如:文章内容出现网站首页目标关键词时做个链接指向首页,出现其他文章关键词时同样做链接指向那篇文章地址 (即锚文本)。蜘蛛判断网站内部权重是根据站内的链接多少决定的,因此内链建设合理的话,普通的词不做外链也可以获得较好的排行。

六、相关性

网站内容相关性是搜索引擎比较看种的一点,例如:文章的主题内容是否与关键词相关、外链的相关性,友情链接的网站是否与自己网站内容相关,百度关键词排名优化,关键词布局和出现的位置、关键词词频、文章内的相关文章,内链的锚文字等等就会对你的关键词排行有一定的影响。

七、百度富含该网站相关关键词的多少

百度收录网站的相关关键词越多,关键词排行,就越容易获得较好的排行。但不是一定的!就像第四点所说的一样,并不一定越多越好。

八、更新规律

网站每天定时定量更新文章和网站内容,外链平稳的下降,内链合理的建设,不要间断,或者大起大落,这样坚持下去相信你的站一定会有不错的权重。

优化怎么做就能快速实现网站排名?

一、差异化优化网站

差异化优化网站是构建在学会剖析同行竞争的基础之上,满足同行网站没有满足的用户需求,同行满足了的用户需求,要比同行网站的体验度更好才行。也即是满足用户热门需求至关重要,传统的优化通道,就是网站三大标签优化,当下起决定性作用的标签为网站标题(title)。当然还有另外一种疗效更佳的时效性热门通道,有2种操作方式,一种是制做专题页面,内容涵括所有用户的热门需求,可以借助百度指数—需求图谱来实现;另一种是通过制做核心优势,满足用户热门需求,可以结合百度指数_舆情洞察来实现。

二、利用聚合标签引导

搜索引擎把用户来到网站之后逗留在个别页面时间的长短作为判断网站页面得分高低的标准。而产品页面、资讯页面都可以设置聚合标签,若用户来到网站打开的页面内容彰显的是用户的显性需求,而聚合标签引导推荐的页面通常可以设置为用户的隐型需求。因此,运用一些手法、策略和工具挖掘出用户的隐型需求也是有必要的。这就是聚合标签的作用,无疑提升网站页面得分须要聚合标签的优化和引导,让你的用户更能满足用户体验,让你的网站页面更符合搜索引擎的规则。

三、合理布局关键词

对关键词进行合理布局,做目标词的锚文本内链,可以促进关键词的排行,从而实现网站的快速排行

关键词排行提高工具-关键词排行-深圳市企翔网路由深圳市企翔网络科技有限公司提供。行路致远,砥砺前行。深圳市企翔网络科技有限公司()致力成为与您共赢、共生、共同前行的战略伙伴,更矢志成为软件开发较具影响力的企业,与您一起飞越,共同成功!同时本公司()还是专业从事高档网站开发,高端网站定制,高端网站设计的厂家,欢迎来电咨询。 查看全部

关键词排行提高工具-关键词排行-深圳市企翔网路

如何能够防止网站改版导致网站关键词的排行影响?

1、网站结构不要大幅度改动

站改版尽量一次到位,关键词排行提高工具,避免短期内反复更改。尤其是URL有变化时,搜索引擎对大量新出现的URL会太敏感,需要重新收录、计算权重,也太可能出现一段沙盒期。如果不能一次完成,多次修改太可能对网站产生重大不好影响。建议本地提早布署更改,待调试修改完毕后再将更改部份全部上传服务器,一次性到位;

2、网站模板不能随便改动

搜索引擎在抓取网页时,先读取的就是网页标题,所以title是否正确设置非常重要;keyword,是用户不查看源代码看不到的。主要作用是告诉搜索引擎本页内容是围绕什么词展开的。因此keyword的每位词都要能在内容中找到相应匹配,才有利于排行。description,和前面的keyword一样,是用户不查看源代码看不到的,而且也是对于一个网页的简略内容概况。

影响一个网站关键词排名的诱因有什么?

影响网站关键词排名的诱因是哪些?就有什么?如何能够使网站关键词的排行迅速提高,应该是每位seo优化人员正在做的事情,新手似乎正在摸索,这也是你们仍然想了解的问题,那么影响网站关键词排名的诱因是哪些呢?我们应当怎样做能够快速提高网站关键词在搜索引擎种的的排行呢?

一、网站服务器稳定性:

网站服务器稳定性和速率是直接影响网站关键词的排行的重要诱因,如果蜘蛛来爬行你网站的时侯,服务器截瘫,无法打开,蜘蛛难以抓取网页,导致网页权重减少,甚至从索引中剔除,相关页面关键词排名会遭到严重影响,建议及时更换服务器,杜绝不必要的影响,免得欲哭无泪;

二、网站权重

一个高权重的网站关键词是很容易获得挺好的排行的,这样的事例比比皆是。有些老站站长喜欢去转载新站或则采集权重较低的网站作为自己的文章,排名常常比被采集的新站要好。

三、所发送的文章或者是否原创

相信你们都晓得原创文章比采集的、copy的内容更受搜索引擎欢迎和倡导。因此搜索引擎会对原创的内容给与相对较高的权重,并不是说采集的文章排名就一定排行不好,但假如你要常年做站的话,那么你一定要原创!经过搜索引擎一段时间的观察,你的权重会得到一定的加分。

四、网站的外链

首先说下,外链越多不一定越好!不一定能提高关键词排行!关键在于外链的权重和相关性。例如:一个采集的垃圾站或则富含不好内容的网站给你做全站链接,虽然外链数目庞大可以很容易达到上万,如何优化关键词排行,你的关键词排行又能提高多少呢?也许还比不上高权重高相关性的网站给你做的一个链接锚文原本的实在。那么怎样建设外链呢?

五、网站内部做内链

网站内链也是一个影响关键词排名的重要诱因,合理的内链建设可以集中权重,权重的传递,蜘蛛的爬行,通过逻辑结构和化学结构的优化可以使蜘蛛更好的抓取但是构建更好传递页与页见的权重。例如:文章内容出现网站首页目标关键词时做个链接指向首页,出现其他文章关键词时同样做链接指向那篇文章地址 (即锚文本)。蜘蛛判断网站内部权重是根据站内的链接多少决定的,因此内链建设合理的话,普通的词不做外链也可以获得较好的排行。

六、相关性

网站内容相关性是搜索引擎比较看种的一点,例如:文章的主题内容是否与关键词相关、外链的相关性,友情链接的网站是否与自己网站内容相关,百度关键词排名优化,关键词布局和出现的位置、关键词词频、文章内的相关文章,内链的锚文字等等就会对你的关键词排行有一定的影响。

七、百度富含该网站相关关键词的多少

百度收录网站的相关关键词越多,关键词排行,就越容易获得较好的排行。但不是一定的!就像第四点所说的一样,并不一定越多越好。

八、更新规律

网站每天定时定量更新文章和网站内容,外链平稳的下降,内链合理的建设,不要间断,或者大起大落,这样坚持下去相信你的站一定会有不错的权重。

优化怎么做就能快速实现网站排名?

一、差异化优化网站

差异化优化网站是构建在学会剖析同行竞争的基础之上,满足同行网站没有满足的用户需求,同行满足了的用户需求,要比同行网站的体验度更好才行。也即是满足用户热门需求至关重要,传统的优化通道,就是网站三大标签优化,当下起决定性作用的标签为网站标题(title)。当然还有另外一种疗效更佳的时效性热门通道,有2种操作方式,一种是制做专题页面,内容涵括所有用户的热门需求,可以借助百度指数—需求图谱来实现;另一种是通过制做核心优势,满足用户热门需求,可以结合百度指数_舆情洞察来实现。

二、利用聚合标签引导

搜索引擎把用户来到网站之后逗留在个别页面时间的长短作为判断网站页面得分高低的标准。而产品页面、资讯页面都可以设置聚合标签,若用户来到网站打开的页面内容彰显的是用户的显性需求,而聚合标签引导推荐的页面通常可以设置为用户的隐型需求。因此,运用一些手法、策略和工具挖掘出用户的隐型需求也是有必要的。这就是聚合标签的作用,无疑提升网站页面得分须要聚合标签的优化和引导,让你的用户更能满足用户体验,让你的网站页面更符合搜索引擎的规则。

三、合理布局关键词

对关键词进行合理布局,做目标词的锚文本内链,可以促进关键词的排行,从而实现网站的快速排行

关键词排行提高工具-关键词排行-深圳市企翔网路由深圳市企翔网络科技有限公司提供。行路致远,砥砺前行。深圳市企翔网络科技有限公司()致力成为与您共赢、共生、共同前行的战略伙伴,更矢志成为软件开发较具影响力的企业,与您一起飞越,共同成功!同时本公司()还是专业从事高档网站开发,高端网站定制,高端网站设计的厂家,欢迎来电咨询。

提升网站流量的方式

采集交流 • 优采云 发表了文章 • 0 个评论 • 152 次浏览 • 2020-08-22 15:08

我们的网站建好后,都会给网站做SEO优化,让网站有更大的流量,通过流量来达到转化量,那么怎么样能够做好优化呢?如何能够提高网站的自然流量呢?我们一起来通过这种内容了解一下。

1、优化长尾关键词

对于优化长尾关键词是一个不错的选择,因为,如果我们一开始都优化主关键词的话,那么,优化的时间长,见效长,竞争大等特征,不适宜在短时间优化起来,那么对于,长尾关键词显著挺好,因为,对于长尾关键词来说,搜索指数低,竞争压力小等,在数天不能优化起来,再加上做的长尾关键词的数目越多,那么,快速带来流量的疗效才会越大。

2、404页面与错误页面重定向

对于企业网站来说,很多页面都会形成错误页面,我们不要简单地址对HTACCESS中手动将404错页面重定向在首页,对于谷歌搜索引擎来说,它也是这样定义一个404错误页面,对于一些做得好的网站它会把那种错误页面指向相关内容的页面上面去。这样,能使用户去访问与内容相关的内容,让用户感觉不到是内容的缺位的存在。

3、UGC优化

UGC优化是须要进行指出的,对一个页面的内容质量高与低,这全靠页面内容的丰富性来说的,对于好多的站长不太注重对用户给我们平台进行主动的添加页面内容数据,小编觉得,这不是挺好的。如果使用户主动来参与优化我们页面内容,丰富页面这不是更好,这样搜索引擎会愈发的欢迎。

4、网站的更新频度

网站的更新频度也是特别的重要,如果,你每一天更新一篇高质量的文章,那么,对于你网站的排行就会有很大的提高,包括关键词等等,如果你的网站更新频度太低,那么,搜索引擎爬虫来访问的次数都会越来越低,也许到某三天都会不来访问网站,这样对网站排名等问题都会受很大的影响。

5、网站内容的重复性

对于网站来说,尽量重复的内容不需要太多,对于用户来说,内容重复得好多,那么,用户就不会断续来访问网站。搜索引擎来说,它会觉得,网站的价值不高,等问题。

SEO优化的容易出现的误区:

1、 定位确切

对于刚才完成SEO优化的小白们,由于自己没有相关的经验,基本上是从零开始,开始优化的时侯不要去做指数比较高的关键词,更不要做自己没有信心的关键词,同时,也不要要求自己在不现实的时间内优化起来。做优化须要一步一步脚印。

2、 拿来主义

对于拿来主义我是想从另一个角度来说,并不是指拿来主义不好,而是,我们在用来的时侯,需要更深层次去理解,是否须要进行调整,根据自己的情况进行调整等,不要一点都不进行调整就使用,那么,学习不到最为根本的东西。

3、 关键词拼凑

关键词的拼凑,在好多的的SEO优化学习资料当中出现,对于搜索引擎也进行多次进行指出,简单来说,我们不需要为优化而优化,那样是不会有挺好的疗效,也有可能造成更为严重的后果。

4、 频繁的更改TDK

如果我们进行频繁的进行更改网站或页面的标题、关键词、描述,那么,对网站的优化是完全没有疗效,严重会影响到权重等。

5、 关键词定位错误

关键词定位的错误,是一个十分严重的问题,如果关键词定位错误,会直接影响到网站的跳出率,就算是关键词有了挺好的排行,也不会有好多的流量。因为,搜索下来的关键词与用户想要的内容不一致。

6、 内容通过采集、转载

很多的站长想节少时间,通过一些采集工具来进行采集,转载,那么,搜索引擎会如何去觉得,这样,搜索引擎也只会觉得是一个用垃圾堆积儿成的的网站,没有任何网站质量,等还包括,内容的更新都须要我们去做。

AD:【5G云技术交流群】入群打赏¥5,打赏备注QQ号,核对后进群 查看全部

提升网站流量的方式

我们的网站建好后,都会给网站做SEO优化,让网站有更大的流量,通过流量来达到转化量,那么怎么样能够做好优化呢?如何能够提高网站的自然流量呢?我们一起来通过这种内容了解一下。

1、优化长尾关键词

对于优化长尾关键词是一个不错的选择,因为,如果我们一开始都优化主关键词的话,那么,优化的时间长,见效长,竞争大等特征,不适宜在短时间优化起来,那么对于,长尾关键词显著挺好,因为,对于长尾关键词来说,搜索指数低,竞争压力小等,在数天不能优化起来,再加上做的长尾关键词的数目越多,那么,快速带来流量的疗效才会越大。

2、404页面与错误页面重定向

对于企业网站来说,很多页面都会形成错误页面,我们不要简单地址对HTACCESS中手动将404错页面重定向在首页,对于谷歌搜索引擎来说,它也是这样定义一个404错误页面,对于一些做得好的网站它会把那种错误页面指向相关内容的页面上面去。这样,能使用户去访问与内容相关的内容,让用户感觉不到是内容的缺位的存在。

3、UGC优化

UGC优化是须要进行指出的,对一个页面的内容质量高与低,这全靠页面内容的丰富性来说的,对于好多的站长不太注重对用户给我们平台进行主动的添加页面内容数据,小编觉得,这不是挺好的。如果使用户主动来参与优化我们页面内容,丰富页面这不是更好,这样搜索引擎会愈发的欢迎。

4、网站的更新频度

网站的更新频度也是特别的重要,如果,你每一天更新一篇高质量的文章,那么,对于你网站的排行就会有很大的提高,包括关键词等等,如果你的网站更新频度太低,那么,搜索引擎爬虫来访问的次数都会越来越低,也许到某三天都会不来访问网站,这样对网站排名等问题都会受很大的影响。

5、网站内容的重复性

对于网站来说,尽量重复的内容不需要太多,对于用户来说,内容重复得好多,那么,用户就不会断续来访问网站。搜索引擎来说,它会觉得,网站的价值不高,等问题。

SEO优化的容易出现的误区:

1、 定位确切

对于刚才完成SEO优化的小白们,由于自己没有相关的经验,基本上是从零开始,开始优化的时侯不要去做指数比较高的关键词,更不要做自己没有信心的关键词,同时,也不要要求自己在不现实的时间内优化起来。做优化须要一步一步脚印。

2、 拿来主义

对于拿来主义我是想从另一个角度来说,并不是指拿来主义不好,而是,我们在用来的时侯,需要更深层次去理解,是否须要进行调整,根据自己的情况进行调整等,不要一点都不进行调整就使用,那么,学习不到最为根本的东西。

3、 关键词拼凑

关键词的拼凑,在好多的的SEO优化学习资料当中出现,对于搜索引擎也进行多次进行指出,简单来说,我们不需要为优化而优化,那样是不会有挺好的疗效,也有可能造成更为严重的后果。

4、 频繁的更改TDK

如果我们进行频繁的进行更改网站或页面的标题、关键词、描述,那么,对网站的优化是完全没有疗效,严重会影响到权重等。

5、 关键词定位错误

关键词定位的错误,是一个十分严重的问题,如果关键词定位错误,会直接影响到网站的跳出率,就算是关键词有了挺好的排行,也不会有好多的流量。因为,搜索下来的关键词与用户想要的内容不一致。

6、 内容通过采集、转载

很多的站长想节少时间,通过一些采集工具来进行采集,转载,那么,搜索引擎会如何去觉得,这样,搜索引擎也只会觉得是一个用垃圾堆积儿成的的网站,没有任何网站质量,等还包括,内容的更新都须要我们去做。

AD:【5G云技术交流群】入群打赏¥5,打赏备注QQ号,核对后进群

核心方法:PHP+MYSQL开源超强SEO企业网站源码(关键词挖掘+几十套模板)

采集交流 • 优采云 发表了文章 • 0 个评论 • 188 次浏览 • 2020-11-07 10:02

模板介绍

PHP超级SEO企业网站源代码(带有关键词挖掘+数十个模板),该程序是基于PHP + MYSQL开发和生产的,其基础程序是THINIKPHP的二次开发。具有关键词挖掘功能!!!!这是非常强大的。 SEO网站的必备工具!此外,还有数十个前端模板。毫不夸张地说这是一个小型的自助式网站构建系统!

该程序的优点如下:

1、都是开源的,这很重要!

2、关键词挖掘功能。 (它比某些挖掘软件更强大)。根据第一点,您可以自己进行一些研究!!!

3、数十个前端模板,您可以根据需要更改它们。

谈论该程序的优缺点:

1、接口未充分优化,响应速度有点慢! (我不知道这是不是我的机器的问题)

2、前景模板几乎不起作用。 (使用一般企业站点时没问题)

下载说明

下载说明:

A:是的,是的,收录演示站的织梦模板已经过严格测试。效果图和演示站均来自模板,可以保证相同!我们没有对免费模板进行太多测试,请自行下载并测试!

由于该站点的客户服务人员精力有限,除了一些付费的织梦模板外,其他模板可免费共享,并且不提供技术支持。

A:我们网站上的模板标记为免费,并且减压密码直接共享。请仔细检查模板说明。

A:为了您的利益,请找出来!对您和我们都有好处!

A:现在联系我们!

在线客户服务 查看全部

PHP + MYSQL开源超级SEO企业网站源代码(关键词挖掘+数十个模板)

模板介绍

PHP超级SEO企业网站源代码(带有关键词挖掘+数十个模板),该程序是基于PHP + MYSQL开发和生产的,其基础程序是THINIKPHP的二次开发。具有关键词挖掘功能!!!!这是非常强大的。 SEO网站的必备工具!此外,还有数十个前端模板。毫不夸张地说这是一个小型的自助式网站构建系统!

该程序的优点如下:

1、都是开源的,这很重要!

2、关键词挖掘功能。 (它比某些挖掘软件更强大)。根据第一点,您可以自己进行一些研究!!!

3、数十个前端模板,您可以根据需要更改它们。

谈论该程序的优缺点:

1、接口未充分优化,响应速度有点慢! (我不知道这是不是我的机器的问题)

2、前景模板几乎不起作用。 (使用一般企业站点时没问题)

下载说明

下载说明:

A:是的,是的,收录演示站的织梦模板已经过严格测试。效果图和演示站均来自模板,可以保证相同!我们没有对免费模板进行太多测试,请自行下载并测试!

由于该站点的客户服务人员精力有限,除了一些付费的织梦模板外,其他模板可免费共享,并且不提供技术支持。

A:我们网站上的模板标记为免费,并且减压密码直接共享。请仔细检查模板说明。

A:为了您的利益,请找出来!对您和我们都有好处!

A:现在联系我们!

在线客户服务

教程:Python与seo工具脚本,360/搜狗相关搜索词采集源码参考

采集交流 • 优采云 发表了文章 • 0 个评论 • 543 次浏览 • 2020-10-25 11:01

与搜索引擎相关的搜索词应为[s5]扩展的类别,许多人正在寻找并选择使用,除了流行的与百度相关的搜索词采集之外,当然还有360个搜索引擎和Sogou搜索引擎,我当然知道方法,将来python的实现基本上是相同的,您唯一需要关心的就是单词本身和反爬坡的限制!

不,这是该败类在360搜索中的第二次推翻。请注意,这是第二次。在采集 360搜索问题和答案期间,处女第一次翻车或汽车翻车。我忘了伤疤真是太好了,太久了! !

360搜索会大力创造奇迹,而不是正确地,大力产生验证码。

此渣是在这里使用常规规则实现相关关键词采集的方法,参考了大量源代码,采用常规规则更加方便快捷!

360个搜索相关的关键词键源代码

re.findall(r'(.+?)</a>', html, re.S | re.I)

搜狗搜索相关的关键词关键源代码

您可以自己参考和学习,毕竟没有什么可谈论的!

附加与关键词 采集相关的360搜索源代码,以供参考和学习! PS:我没有写代码。顽固的学习被废除了。怎么写呢? !

#!/usr/bin/env python3

# -*- coding: utf-8 -*-

"""

360相关搜索词挖掘脚本(多线程版)

基于python3.8

需要安装requests模块

@author:微信/huguo00289

"""

import re

from queue import Queue

from threading import Thread

import requests,random

class Qh360Spider(Thread):

result = {} # 保存结果字典

seen = set() # 表示在队列中的关键词(已抓取或待抓取)

def __init__(self, kw_queue, loop, failed):

super(Qh360Spider, self).__init__()

self.kw_queue = kw_queue # 关键词队列

self.loop = loop # 循环挖词拓展次数

self.failed = failed # 保存查询失败的关键词文件

self.ua_list = [

'Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/535.1 (KHTML, like Gecko) Chrome/14.0.835.163 Safari/535.1',

'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/73.0.3683.103 Safari/537.36Chrome 17.0',

'Mozilla/5.0 (Macintosh; Intel Mac OS X 10_7_0) AppleWebKit/535.11 (KHTML, like Gecko) Chrome/17.0.963.56 Safari/535.11',

'Mozilla/5.0 (Windows NT 6.1; WOW64; rv:6.0) Gecko/20100101 Firefox/6.0Firefox 4.0.1',

'Mozilla/5.0 (Macintosh; Intel Mac OS X 10.6; rv:2.0.1) Gecko/20100101 Firefox/4.0.1',

'Mozilla/5.0 (Macintosh; U; Intel Mac OS X 10_6_8; en-us) AppleWebKit/534.50 (KHTML, like Gecko) Version/5.1 Safari/534.50',

'Mozilla/5.0 (Windows; U; Windows NT 6.1; en-us) AppleWebKit/534.50 (KHTML, like Gecko) Version/5.1 Safari/534.50',

'Opera/9.80 (Windows NT 6.1; U; en) Presto/2.8.131 Version/11.11',

]

def run(self): # 程序的执行流程

while True:

# 从队列里面获取一个关键词及其对应的当前拓展次数

kw, cloop = self.kw_queue.get()

print('CurLoop:{} Checking: {}'.format(cloop, kw))

query = 'https://www.so.com/s?q={}'.format(kw) # 构建含关键词的url

try:

source = self.download(query, timeout=10)

# source = self.download(query,timeout=10,user_agent=self.ua)

if source:

kw_list = self.extract(source)

print(kw_list)

self.filter(cloop, kw_list)

else:

# 获取源码失败,保存查询失败的关键词

self.failed.write('{}\n'.format(kw))

finally:

self.kw_queue.task_done()

def download(self, url, timeout=5, proxy=None, num_retries=5):

"""

通用网页源码下载函数

:param url: 要下载的url

:param timeout: 请求超时时间,单位/秒。可能某些网站的反应速度很慢,所以需要一个连接超时变量来处理。

:param user_agent: 用户代理信息,可以自定义是爬虫还是模拟用户

:param proxy: ip代理(http代理),访问某些国外网站的时候需要用到。必须是双元素元组或列表(‘ip:端口’,‘http/https’)

:param num_retries: 失败重试次数

:return: HTML网页源码

"""

headers = {

"Cookie": "QiHooGUID=41F80B0CCE5D43A22EEF0305A12CDE3F.1596003342506; __guid=15484592.2994995584481314300.1596003341831.5723; soid=TjzBKt3zrO-Rh1S7fXSb0S!6kmX5TlEerB2URZz9v4; __md=667cb161f9515972323507763d8fa7dd643a65bd2e88034.9; dpr=1; isafe=1; webp=1; _uc_m2=886a48052dbb9e2291f80055746e0d4f1f110f922b2f; _uc_mid=7cb161f953d8fa7dd643a65bd2e88034; __huid=11xZqhEl%2FfVeqclI4j%2BdQeQvX63Oph%2F%2BCVM5vxqYGxQI4%3D; Q=u%3Duhthb002%26n%3D%26le%3DAwH0ZGV5ZGR3WGDjpKRhL29g%26m%3DZGH5WGWOWGWOWGWOWGWOWGWOZGL0%26qid%3D144048053%26im%3D1_t018c25fbb66797efb2%26src%3D360chrome%26t%3D1; T=s%3D2afa764886f737dd5d23421c30f87a1f%26t%3D1595934758%26lm%3D0-1%26lf%3D2%26sk%3De485bbde46ac34fc27fc40215de76c44%26mt%3D1595934758%26rc%3D1%26v%3D2.0%26a%3D1; _S=tg75a7e3fmv0mfdfkt8jlpfpj6; stc_ls_sohome=RRzRSR!RTR(RUR_RVR; gtHuid=1; homeopenad=1; _pp_wd=1; _ga=GA1.2.607533084.1598082638; _gid=GA1.2.1887117715.1598082638; count=6; erules=p1-9%7Cp2-11%7Cp4-3%7Cecl-2%7Ckd-1%7Cp3-2",

'User-Agent': random.choice(self.ua_list)

}

try:

# 打开网页并读取内容存入html变量中

resp = requests.get(url, headers=headers, proxies=proxy, timeout=timeout)

print(resp.status_code)

except requests.RequestException as err:

print('Download error:', err)

html = None # 如果有异常,那么html肯定是没获取到的,所以赋值None

if num_retries > 0:

return self.download(url, timeout, proxy, num_retries - 1)

else:

html = resp.content.decode('utf-8')

#print(html)

return html

@staticmethod

def extract(html):

'''

提取关键词

:param html:搜索结果源码

:return:提取出来的相关关键词列表

'''

return re.findall(r'(.+?)</a>', html, re.S | re.I)

def filter(self, current_loop, kwlist):

'''

关键词过滤和统计函数

:param current_loop: 当前拓展的次数

:param kwlist: 提取出来的关键词列表

:return: None

'''

for kw in kwlist:

# 判断关键词是不是已经被抓取或者已经存在关键词队列

# 判断当前的拓展次数是否已经超过指定值

if current_loop 0:

print("有东西")

print('111')

save.write(line)

save.flush() # 刷新缓存,避免中途出错

save.close()

print('done,完成挖掘')

如果您无权访问ip代理,那么进行协调非常容易。毕竟,要大力生成验证码。尝试后,速度仍然可以,但是太容易被360搜索防爬升阻止。如果您想要正常且稳定的操作,则不知道如何访问代理IP,那么必须同时存在一个cookie库!

查看全部

Python和seo工具脚本,与360 / Sogou相关的搜索词采集源代码参考

与搜索引擎相关的搜索词应为[s5]扩展的类别,许多人正在寻找并选择使用,除了流行的与百度相关的搜索词采集之外,当然还有360个搜索引擎和Sogou搜索引擎,我当然知道方法,将来python的实现基本上是相同的,您唯一需要关心的就是单词本身和反爬坡的限制!

不,这是该败类在360搜索中的第二次推翻。请注意,这是第二次。在采集 360搜索问题和答案期间,处女第一次翻车或汽车翻车。我忘了伤疤真是太好了,太久了! !

360搜索会大力创造奇迹,而不是正确地,大力产生验证码。

此渣是在这里使用常规规则实现相关关键词采集的方法,参考了大量源代码,采用常规规则更加方便快捷!

360个搜索相关的关键词键源代码

re.findall(r'(.+?)</a>', html, re.S | re.I)

搜狗搜索相关的关键词关键源代码

您可以自己参考和学习,毕竟没有什么可谈论的!

附加与关键词 采集相关的360搜索源代码,以供参考和学习! PS:我没有写代码。顽固的学习被废除了。怎么写呢? !

#!/usr/bin/env python3

# -*- coding: utf-8 -*-

"""

360相关搜索词挖掘脚本(多线程版)

基于python3.8

需要安装requests模块

@author:微信/huguo00289

"""

import re

from queue import Queue

from threading import Thread

import requests,random

class Qh360Spider(Thread):

result = {} # 保存结果字典

seen = set() # 表示在队列中的关键词(已抓取或待抓取)

def __init__(self, kw_queue, loop, failed):

super(Qh360Spider, self).__init__()

self.kw_queue = kw_queue # 关键词队列

self.loop = loop # 循环挖词拓展次数

self.failed = failed # 保存查询失败的关键词文件

self.ua_list = [

'Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/535.1 (KHTML, like Gecko) Chrome/14.0.835.163 Safari/535.1',

'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/73.0.3683.103 Safari/537.36Chrome 17.0',

'Mozilla/5.0 (Macintosh; Intel Mac OS X 10_7_0) AppleWebKit/535.11 (KHTML, like Gecko) Chrome/17.0.963.56 Safari/535.11',

'Mozilla/5.0 (Windows NT 6.1; WOW64; rv:6.0) Gecko/20100101 Firefox/6.0Firefox 4.0.1',

'Mozilla/5.0 (Macintosh; Intel Mac OS X 10.6; rv:2.0.1) Gecko/20100101 Firefox/4.0.1',

'Mozilla/5.0 (Macintosh; U; Intel Mac OS X 10_6_8; en-us) AppleWebKit/534.50 (KHTML, like Gecko) Version/5.1 Safari/534.50',

'Mozilla/5.0 (Windows; U; Windows NT 6.1; en-us) AppleWebKit/534.50 (KHTML, like Gecko) Version/5.1 Safari/534.50',

'Opera/9.80 (Windows NT 6.1; U; en) Presto/2.8.131 Version/11.11',

]

def run(self): # 程序的执行流程

while True:

# 从队列里面获取一个关键词及其对应的当前拓展次数

kw, cloop = self.kw_queue.get()

print('CurLoop:{} Checking: {}'.format(cloop, kw))

query = 'https://www.so.com/s?q={}'.format(kw) # 构建含关键词的url

try:

source = self.download(query, timeout=10)

# source = self.download(query,timeout=10,user_agent=self.ua)

if source:

kw_list = self.extract(source)

print(kw_list)

self.filter(cloop, kw_list)

else:

# 获取源码失败,保存查询失败的关键词

self.failed.write('{}\n'.format(kw))

finally:

self.kw_queue.task_done()

def download(self, url, timeout=5, proxy=None, num_retries=5):

"""

通用网页源码下载函数

:param url: 要下载的url

:param timeout: 请求超时时间,单位/秒。可能某些网站的反应速度很慢,所以需要一个连接超时变量来处理。

:param user_agent: 用户代理信息,可以自定义是爬虫还是模拟用户

:param proxy: ip代理(http代理),访问某些国外网站的时候需要用到。必须是双元素元组或列表(‘ip:端口’,‘http/https’)

:param num_retries: 失败重试次数

:return: HTML网页源码

"""

headers = {

"Cookie": "QiHooGUID=41F80B0CCE5D43A22EEF0305A12CDE3F.1596003342506; __guid=15484592.2994995584481314300.1596003341831.5723; soid=TjzBKt3zrO-Rh1S7fXSb0S!6kmX5TlEerB2URZz9v4; __md=667cb161f9515972323507763d8fa7dd643a65bd2e88034.9; dpr=1; isafe=1; webp=1; _uc_m2=886a48052dbb9e2291f80055746e0d4f1f110f922b2f; _uc_mid=7cb161f953d8fa7dd643a65bd2e88034; __huid=11xZqhEl%2FfVeqclI4j%2BdQeQvX63Oph%2F%2BCVM5vxqYGxQI4%3D; Q=u%3Duhthb002%26n%3D%26le%3DAwH0ZGV5ZGR3WGDjpKRhL29g%26m%3DZGH5WGWOWGWOWGWOWGWOWGWOZGL0%26qid%3D144048053%26im%3D1_t018c25fbb66797efb2%26src%3D360chrome%26t%3D1; T=s%3D2afa764886f737dd5d23421c30f87a1f%26t%3D1595934758%26lm%3D0-1%26lf%3D2%26sk%3De485bbde46ac34fc27fc40215de76c44%26mt%3D1595934758%26rc%3D1%26v%3D2.0%26a%3D1; _S=tg75a7e3fmv0mfdfkt8jlpfpj6; stc_ls_sohome=RRzRSR!RTR(RUR_RVR; gtHuid=1; homeopenad=1; _pp_wd=1; _ga=GA1.2.607533084.1598082638; _gid=GA1.2.1887117715.1598082638; count=6; erules=p1-9%7Cp2-11%7Cp4-3%7Cecl-2%7Ckd-1%7Cp3-2",

'User-Agent': random.choice(self.ua_list)

}

try:

# 打开网页并读取内容存入html变量中

resp = requests.get(url, headers=headers, proxies=proxy, timeout=timeout)

print(resp.status_code)

except requests.RequestException as err:

print('Download error:', err)

html = None # 如果有异常,那么html肯定是没获取到的,所以赋值None

if num_retries > 0:

return self.download(url, timeout, proxy, num_retries - 1)

else:

html = resp.content.decode('utf-8')

#print(html)

return html

@staticmethod

def extract(html):

'''