关键词文章采集源码

关键词文章采集源码(人人商城,小程序,商业源码,微信营销源码wp)

采集交流 • 优采云 发表了文章 • 0 个评论 • 153 次浏览 • 2021-09-07 03:11

2.您必须在下载后24小时内从您的电脑中彻底删除以上内容资源!

3.如果你也有好的源码或者教程,可以直接发布到会员中心。分享,购买就有收益!可以提现!

4. 本站提供的源代码、模板、插件等资源不收录技术服务。请原谅我!如果连基本的小程序都不会安装,请先在网站上购买小程序安装教程,然后再购买源代码!

5.如有链接无法下载、无效或有广告,请联系管理员QQ处理!

6.本站资源价格仅为赞助,收取的费用仅用于维持本站日常运营!

7. 本站不保证所提供下载资源的准确性、安全性和完整性,源代码仅供下载学习使用!没有人能保证程序没有bug,如果你想花几块钱来享受正版的服务!请远离本站!源代码可复现,若开启关闭退款,谢绝补贴购买!

8.如用于商业或非法用途,与本站无关,一切后果由用户负责!

9. 如果遇到加密的压缩包,默认解压密码为“”。如无法解压,请联系管理员!

动能代码站被众多网友分享:php源代码、商业源代码、wp主题、人人商店、破解模块、商业插件、微信小程序、小程序源代码、微信小程序源代码、织梦template、微信营销源码、破解软件工具等资源!

动能代码»wordpress采集resource插件:胖鼠采集 查看全部

关键词文章采集源码(人人商城,小程序,商业源码,微信营销源码wp)

2.您必须在下载后24小时内从您的电脑中彻底删除以上内容资源!

3.如果你也有好的源码或者教程,可以直接发布到会员中心。分享,购买就有收益!可以提现!

4. 本站提供的源代码、模板、插件等资源不收录技术服务。请原谅我!如果连基本的小程序都不会安装,请先在网站上购买小程序安装教程,然后再购买源代码!

5.如有链接无法下载、无效或有广告,请联系管理员QQ处理!

6.本站资源价格仅为赞助,收取的费用仅用于维持本站日常运营!

7. 本站不保证所提供下载资源的准确性、安全性和完整性,源代码仅供下载学习使用!没有人能保证程序没有bug,如果你想花几块钱来享受正版的服务!请远离本站!源代码可复现,若开启关闭退款,谢绝补贴购买!

8.如用于商业或非法用途,与本站无关,一切后果由用户负责!

9. 如果遇到加密的压缩包,默认解压密码为“”。如无法解压,请联系管理员!

动能代码站被众多网友分享:php源代码、商业源代码、wp主题、人人商店、破解模块、商业插件、微信小程序、小程序源代码、微信小程序源代码、织梦template、微信营销源码、破解软件工具等资源!

动能代码»wordpress采集resource插件:胖鼠采集

关键词文章采集源码(系统>系统基本参数>核心参数>关键字替换次数(是/否))

采集交流 • 优采云 发表了文章 • 0 个评论 • 128 次浏览 • 2021-09-06 12:07

1、System> System Basic Parameters> Core Parameters> Keyword Replacement (Yes/No) 使用此功能会影响HTML生成速度:选择DEDEcmstutorial

2、Core> 批量维护> 文档关键词system:这里添加关键词和url对应表

3、发布文章时,关键词必须添加关键词,否则即使文章出现关键词也不会自动添加链接。

显然第三点做起来很麻烦。如果是采集,是不可能做到的。还有一点就是如果文章在默认设置中出现多次,会增加5次链接,添加这么多链接显然不符合SEO。以下两点还不足以进行修改:

先修改第3点,这样在发布文章时,可以通过修改/include/arc.archives.class,自动添加链接,无需在关键词自动链接列表中添加关键词。 php,找到如下代码

foreach($kws as $k) <br /> { $k = trim($k); <br /> if($k!="") <br /> { if($i > $maxkey) <br /> { break; } <br /> $myrow = $this->dsql->GetOne("select * from dede_keywords where keyword='$k' And rpurl'' "); <br /> if(is_array($myrow)) <br /> { <br /> $karr[] = $k; <br /> $GLOBALS['replaced'][$k] = 0; <br /> $kaarr[] = "$k</a>"; <br /> } <br /> $i++; <br /> } <br /> }

修改为:

global $dsql; $query="SELECT * FROM dede_keywords WHERE rpurl'' ORDER BY rank DESC"; $dsql->SetQuery($query); $dsql->Execute(); while($row = $dsql->GetArray()) { $key = trim($row['keyword']); $key_url=trim($row['rpurl']); $karr[] = $key; $kaarr[] = "$key</a>"; }

我们来看看如何定义关键词replacement 次数。新安装的dede5.6在系统参数>其他选项>文档内容与关键词replacement次数相同(0表示全部替换)。这个参数是定义的,我从5.1升级到5.6,没看到这个参数,不过可以通过在系统参数中添加全局变量来添加>添加全局变量的设置方法是如下

变量名:相同的文档内容关键词replacement次(0表示全部替换)

变量值:cfg_replace_num

变量类型:数字

组:随便你(你可以在你选择的组中找到这个参数)

现在尝试添加另一个文章,或者重新生成原来的文章,关键词是否可以自动添加内部链接? 查看全部

关键词文章采集源码(系统>系统基本参数>核心参数>关键字替换次数(是/否))

1、System> System Basic Parameters> Core Parameters> Keyword Replacement (Yes/No) 使用此功能会影响HTML生成速度:选择DEDEcmstutorial

2、Core> 批量维护> 文档关键词system:这里添加关键词和url对应表

3、发布文章时,关键词必须添加关键词,否则即使文章出现关键词也不会自动添加链接。

显然第三点做起来很麻烦。如果是采集,是不可能做到的。还有一点就是如果文章在默认设置中出现多次,会增加5次链接,添加这么多链接显然不符合SEO。以下两点还不足以进行修改:

先修改第3点,这样在发布文章时,可以通过修改/include/arc.archives.class,自动添加链接,无需在关键词自动链接列表中添加关键词。 php,找到如下代码

foreach($kws as $k) <br /> { $k = trim($k); <br /> if($k!="") <br /> { if($i > $maxkey) <br /> { break; } <br /> $myrow = $this->dsql->GetOne("select * from dede_keywords where keyword='$k' And rpurl'' "); <br /> if(is_array($myrow)) <br /> { <br /> $karr[] = $k; <br /> $GLOBALS['replaced'][$k] = 0; <br /> $kaarr[] = "$k</a>"; <br /> } <br /> $i++; <br /> } <br /> }

修改为:

global $dsql; $query="SELECT * FROM dede_keywords WHERE rpurl'' ORDER BY rank DESC"; $dsql->SetQuery($query); $dsql->Execute(); while($row = $dsql->GetArray()) { $key = trim($row['keyword']); $key_url=trim($row['rpurl']); $karr[] = $key; $kaarr[] = "$key</a>"; }

我们来看看如何定义关键词replacement 次数。新安装的dede5.6在系统参数>其他选项>文档内容与关键词replacement次数相同(0表示全部替换)。这个参数是定义的,我从5.1升级到5.6,没看到这个参数,不过可以通过在系统参数中添加全局变量来添加>添加全局变量的设置方法是如下

变量名:相同的文档内容关键词replacement次(0表示全部替换)

变量值:cfg_replace_num

变量类型:数字

组:随便你(你可以在你选择的组中找到这个参数)

现在尝试添加另一个文章,或者重新生成原来的文章,关键词是否可以自动添加内部链接?

关键词文章采集源码(从阿里云申请技术支持文档下载指定的指定指定源码)

采集交流 • 优采云 发表了文章 • 0 个评论 • 160 次浏览 • 2021-09-05 00:02

关键词文章采集源码demo渲染效果截图。有需要的可以下载,直接用。从阿里云申请技术支持文档下载指定的指定源码(version1.0.0.0-snapshot)链接:密码:j7t此处发布的版本不够高。请下载指定版本。详情访问:aliyun/aliyun-cloud-infrastructure-demo.git。

(demo)使用python3.5.1编写的云平台产品demo演示-最美应用是不是很赞,

为什么没有人回答opencv_example.py,那个简单易懂啊。

javacaffe

免费文档在这里:/jc/5f5a246/

malloc函数是什么?

还在用emtcode改过来吗?

还是从java写的metacaffe,我将参数调整一下,可以参考一下。

如果不是做有监督学习,那就用r语言重写一个可以使用numpy的dataframe,其实libjson也是一种不错的工具,当然实际情况可能要求远比较苛刻,至少,你是要在一个universe里面使用,

用deeplearning的方法做的,

deeplearning

deeplearning_demo下载下来后解压

可以看看视频教程,web是安装cpu的环境,服务器上要单独设置。

我知道有些应用场景不用编译过程,而用r,简单方便。 查看全部

关键词文章采集源码(从阿里云申请技术支持文档下载指定的指定指定源码)

关键词文章采集源码demo渲染效果截图。有需要的可以下载,直接用。从阿里云申请技术支持文档下载指定的指定源码(version1.0.0.0-snapshot)链接:密码:j7t此处发布的版本不够高。请下载指定版本。详情访问:aliyun/aliyun-cloud-infrastructure-demo.git。

(demo)使用python3.5.1编写的云平台产品demo演示-最美应用是不是很赞,

为什么没有人回答opencv_example.py,那个简单易懂啊。

javacaffe

免费文档在这里:/jc/5f5a246/

malloc函数是什么?

还在用emtcode改过来吗?

还是从java写的metacaffe,我将参数调整一下,可以参考一下。

如果不是做有监督学习,那就用r语言重写一个可以使用numpy的dataframe,其实libjson也是一种不错的工具,当然实际情况可能要求远比较苛刻,至少,你是要在一个universe里面使用,

用deeplearning的方法做的,

deeplearning

deeplearning_demo下载下来后解压

可以看看视频教程,web是安装cpu的环境,服务器上要单独设置。

我知道有些应用场景不用编译过程,而用r,简单方便。

关键词文章采集源码(ygbookygbook采集使用教程是怎么配置的?采集配置教程)

采集交流 • 优采云 发表了文章 • 0 个评论 • 150 次浏览 • 2021-09-04 18:25

很多用户不知道ygbook采集是怎么配置的,所以我有一个ygbook采集教程或者ygbook采集配置教程给大家讲解。

ygbook采集方法步骤

第一步-规则导入:登录后台-采集settings-导入规则-打开采集法txt文件复制粘贴后台规则导入栏中的内容

采集point 名字随便写。

第二步-启动采集:background-采集settings-batch 采集新书按钮打开或者点击采集按钮采集每条采集规则后也可以,区别在于批量采集新书按钮可以设置采集次数,规则后面的采集按钮是点击一次采集一次。

第三步-更新小说信息和章节目录数:后台-采集设置-批量处理文章信息按钮,点击挂机即可。

第四步-更新列数据块:后台-更多功能-数据块-更新块数据按钮点击更新块数据,注意:右上角有PC端和wap移动端。

第五步-清除缓存:后台-缓存管理-清理所有可以清理的东西。

注意:如果前台某个分类下没有显示小说,其中一个可能是采集的小说数量不够。重复步骤 1-5。

ygbook小说源码过程简单测试分析采集小说的过程ygbook采集概念分析分析

我们来谈谈ygbook的采集问题。找了半天,ygbook官网也没有消息。研究了很久,发现这个程序很有趣。我们可以将ygbook的数据库理解为三个:

第一个数据库:我们刚开始建网站的时候,网站里没有小说。当然,主页肯定是空的。当我们在后台点击批处理采集小说时,程序会去采集Rule的源站抓取小说网址连接信息并保存在第一个数据库中(我们可以将这个ygbook数据库理解为“小说网址库” " 等待采集小说信息)

第二个数据库:当我们有一个新的URL库时,我们在后台点击批量处理文章信息。此时程序会根据URL库中的URL抓取小说封面,作者、简介、小说章节列表等简单信息不涉及小说章节内容存储在第二个数据库中(我们可以把这个ygbook数据库理解为“小说更新库”)

第三个数据库:当第二个数据库有内容时,即小说更新库,前台会检索显示的内容,然后当用户点击查看小说章节时,程序会抓取此时的章节内容也存储在第三个数据库中(我们可以将这个ygbook数据库理解为“章节内容库”)

注意:当第一个数据库“小说网站库”中有数据时,首页会显示小说名称和分类中最新的小说。当前用户点击小说名称时,程序也会转到采集Fiction数据存储在第二个数据库“小说更新数据库”中,后台批量处理文章信息也是一样。

Ygbook 有三个非常好的功能:

1、就是当我们点击前台小说信息目录页时,他会自动抓取源站对应的小说最新章节并更新第二个数据库,也就是小说更新库很棒:

2、表示当前用户搜索小说时,网站中没有对应的小说。他会将搜索到的小说名称保存在后台搜索记录中,并显示搜索次数和ip结果时间等,方便我们及时知道我们的用户需要这些小说及时补。

3、表示ygbook可以自行原创发表小说,但不支持付费观看,有能力的可以下载。

打了半天,大概表达了自己的理解。请注明孟凌坤博客网站和刘涛钻具制作网站。哈哈 更多问题请留言或看我的另一个文章ygbook FAQ

阅读我的 ygbook采集 教程或 ygbook采集 配置教程怎么样?我应该对采集ygbook 程序有了新的认识。 查看全部

关键词文章采集源码(ygbookygbook采集使用教程是怎么配置的?采集配置教程)

很多用户不知道ygbook采集是怎么配置的,所以我有一个ygbook采集教程或者ygbook采集配置教程给大家讲解。

ygbook采集方法步骤

第一步-规则导入:登录后台-采集settings-导入规则-打开采集法txt文件复制粘贴后台规则导入栏中的内容

采集point 名字随便写。

第二步-启动采集:background-采集settings-batch 采集新书按钮打开或者点击采集按钮采集每条采集规则后也可以,区别在于批量采集新书按钮可以设置采集次数,规则后面的采集按钮是点击一次采集一次。

第三步-更新小说信息和章节目录数:后台-采集设置-批量处理文章信息按钮,点击挂机即可。

第四步-更新列数据块:后台-更多功能-数据块-更新块数据按钮点击更新块数据,注意:右上角有PC端和wap移动端。

第五步-清除缓存:后台-缓存管理-清理所有可以清理的东西。

注意:如果前台某个分类下没有显示小说,其中一个可能是采集的小说数量不够。重复步骤 1-5。

ygbook小说源码过程简单测试分析采集小说的过程ygbook采集概念分析分析

我们来谈谈ygbook的采集问题。找了半天,ygbook官网也没有消息。研究了很久,发现这个程序很有趣。我们可以将ygbook的数据库理解为三个:

第一个数据库:我们刚开始建网站的时候,网站里没有小说。当然,主页肯定是空的。当我们在后台点击批处理采集小说时,程序会去采集Rule的源站抓取小说网址连接信息并保存在第一个数据库中(我们可以将这个ygbook数据库理解为“小说网址库” " 等待采集小说信息)

第二个数据库:当我们有一个新的URL库时,我们在后台点击批量处理文章信息。此时程序会根据URL库中的URL抓取小说封面,作者、简介、小说章节列表等简单信息不涉及小说章节内容存储在第二个数据库中(我们可以把这个ygbook数据库理解为“小说更新库”)

第三个数据库:当第二个数据库有内容时,即小说更新库,前台会检索显示的内容,然后当用户点击查看小说章节时,程序会抓取此时的章节内容也存储在第三个数据库中(我们可以将这个ygbook数据库理解为“章节内容库”)

注意:当第一个数据库“小说网站库”中有数据时,首页会显示小说名称和分类中最新的小说。当前用户点击小说名称时,程序也会转到采集Fiction数据存储在第二个数据库“小说更新数据库”中,后台批量处理文章信息也是一样。

Ygbook 有三个非常好的功能:

1、就是当我们点击前台小说信息目录页时,他会自动抓取源站对应的小说最新章节并更新第二个数据库,也就是小说更新库很棒:

2、表示当前用户搜索小说时,网站中没有对应的小说。他会将搜索到的小说名称保存在后台搜索记录中,并显示搜索次数和ip结果时间等,方便我们及时知道我们的用户需要这些小说及时补。

3、表示ygbook可以自行原创发表小说,但不支持付费观看,有能力的可以下载。

打了半天,大概表达了自己的理解。请注明孟凌坤博客网站和刘涛钻具制作网站。哈哈 更多问题请留言或看我的另一个文章ygbook FAQ

阅读我的 ygbook采集 教程或 ygbook采集 配置教程怎么样?我应该对采集ygbook 程序有了新的认识。

关键词文章采集源码(百度下拉框关键词采集工具和源码,再次分享一下吧!)

采集交流 • 优采云 发表了文章 • 0 个评论 • 184 次浏览 • 2021-09-04 17:02

对于词研究,每个搜索者都必须知道。除了比较热门的百度相关搜索词外,百度下拉框关键词应该也是很多人研究的范围,不过大部分人关注的都是下拉框词的数量,毕竟百度下拉框关键词采集已被淹没。

百度下拉菜单的正式名称是百度建议词,也称为百度建议词或百度下拉菜单。百度为方便广大网友搜索,提高输入效率而推出的一项服务。

例如,当我们在百度中输入“营销”两个词时,百度从推荐词条库中检索以“营销”两个词开头的词条,并按照搜索量从大到小排序,分组为一个下拉菜单。百度下拉菜单最多10个。

百度下拉框关键词的含义:可以作为长尾词,也可以作为标题。毕竟是用户搜索时可以触发的关键词search选择。很多人用下拉词来引导流量,比如曝光品牌,导向指定页面。您可以采集分析竞争对手的相关操作,也可以自己曝光自己的品牌。不同的人有不同的看法!

网上有很多采集下拉词的工具和源码。让我们在这里再次分享它们!

版本一:直接抓取网页实现采集下拉词

def get_keywords(word):

url=f"百度网址/sugrec?pre=1&ie=utf-8&json=1&prod=pc&wd={word}"

html=requests.get(url)

html=html.json()

#print(html)

#print(html['g'])

key_words=[]

对于 html['g'] 中的关键字:

打印(key_word['q'])

key_words.append(key_word['q'])

#print(key_words)

返回key_wordscopy代码

版本二:使用官方接口如:def get_sug(word):

url ='百度官方界面/su?wd=%s&sugmode=2&json=1&p=3&sid=1427_21091_21673_22581&req=2&pbs=%%E5%%BF%%AB%%E6%%89%%8B&csor=%&p=2 E5%%BF%%AB%%E6%%89%%8B&cb=jQuery752020363_68&_=81'%字

r = requests.get(url, verify=False)#请求API接口,取消HTTPS验证

cont = r.content#获取返回的内容

res = cont[41: -2].decode('gbk')#只取返回结果中的一段json格式,解码成unicode

res_json = json.loads(res)#json格式转换

return res_json['s']#返回关键词List复制代码

版本 3:另一个接口地址 def get_word(word):

url=f'另一个百度界面地址/su?wd={word}&sugmode=3&json=1'

html=requests.get(url).text

html=html.replace("window.baidu.sug(",'')

html = html.replace(")",'')

html = html.replace(";",'')

#print(html)

html = json.loads(html)

key_words=html['s']

#print(key_words)

返回key_wordscopy代码

本质上第二个和第三个性质是一样的,我们参考使用吧!

扩展版:这里有个小技巧,就是在关键词后输入w,会出现拼音中w开头的一系列关键词,比如“黄山w”,“黄山温泉”会出现出现,“黄山”玩几天”,“黄山五绝”等等关键词(见上面截图)。因此,当我们遍历a~z时,会出现更多的关键词。 def get_more_word(word ):

more_word=[]

for i in'abcdefghijklmnopqrstuvwxyz':

more_word.extend(get_keywords('%s%s'%(word,i)))

打印(more_word)

打印(len(more_word))

打印(len(list(set(more_word))))

返回列表(set(more_word))#去重操作

def get_more_sug(word):

all_words = []

for i in'abcdefghijklmnopqrstuvwxyz':

all_words += get_sug(word+i)# 遍历字母表 |使用之前的功能

print(len(list(set(all_words))))

return list(set(all_words))#复制代码重复

这里选择了版本2的接口形式,以免不协调。但是如果使用requests模块请求无效的网站,则会直接报错。您可以将 verify 参数设置为 False 来解决这个问题 r = requests.get(url, verify=False ) 但是设置 verify=False 会抛出 InsecureRequestWarning 警告。这看起来很糟糕。解决方案: from requests.packages.urllib3.exceptions import InsecureRequestWarning

#禁用安全请求警告

requests.packages.urllib3.disable_warnings(InsecureRequestWarning)复制代码

运行效果

为了方便大家使用和玩,本渣特为大家打包了低版本的exe工具,方便大家使用!获取百度网盘的exe工具

以下为exe下载信息,可回复!

访客,如果您想查看本帖隐藏内容,请回复

以上代码仅供参考!如果有效,请给个好评,谢谢! !

好评,谢谢! !

66666,值得学习

66666,值得学习

金币+1贡献+5

标签:采集源码解读关键词下拉框

转载:感谢您对Yudi Silent个人博客网站platform的认可,以及网站分享的经验、工具和文章。欢迎分享给您的个人站长或朋友圈,但转载请注明文章出处。

()

上一篇:“SEO工具”百度下拉框关键词无限裂变采集

下一个:111.206.221.*谁知道这个IP段是什么?我一直在扫描我的网站 查看全部

关键词文章采集源码(百度下拉框关键词采集工具和源码,再次分享一下吧!)

对于词研究,每个搜索者都必须知道。除了比较热门的百度相关搜索词外,百度下拉框关键词应该也是很多人研究的范围,不过大部分人关注的都是下拉框词的数量,毕竟百度下拉框关键词采集已被淹没。

百度下拉菜单的正式名称是百度建议词,也称为百度建议词或百度下拉菜单。百度为方便广大网友搜索,提高输入效率而推出的一项服务。

例如,当我们在百度中输入“营销”两个词时,百度从推荐词条库中检索以“营销”两个词开头的词条,并按照搜索量从大到小排序,分组为一个下拉菜单。百度下拉菜单最多10个。

百度下拉框关键词的含义:可以作为长尾词,也可以作为标题。毕竟是用户搜索时可以触发的关键词search选择。很多人用下拉词来引导流量,比如曝光品牌,导向指定页面。您可以采集分析竞争对手的相关操作,也可以自己曝光自己的品牌。不同的人有不同的看法!

网上有很多采集下拉词的工具和源码。让我们在这里再次分享它们!

版本一:直接抓取网页实现采集下拉词

def get_keywords(word):

url=f"百度网址/sugrec?pre=1&ie=utf-8&json=1&prod=pc&wd={word}"

html=requests.get(url)

html=html.json()

#print(html)

#print(html['g'])

key_words=[]

对于 html['g'] 中的关键字:

打印(key_word['q'])

key_words.append(key_word['q'])

#print(key_words)

返回key_wordscopy代码

版本二:使用官方接口如:def get_sug(word):

url ='百度官方界面/su?wd=%s&sugmode=2&json=1&p=3&sid=1427_21091_21673_22581&req=2&pbs=%%E5%%BF%%AB%%E6%%89%%8B&csor=%&p=2 E5%%BF%%AB%%E6%%89%%8B&cb=jQuery752020363_68&_=81'%字

r = requests.get(url, verify=False)#请求API接口,取消HTTPS验证

cont = r.content#获取返回的内容

res = cont[41: -2].decode('gbk')#只取返回结果中的一段json格式,解码成unicode

res_json = json.loads(res)#json格式转换

return res_json['s']#返回关键词List复制代码

版本 3:另一个接口地址 def get_word(word):

url=f'另一个百度界面地址/su?wd={word}&sugmode=3&json=1'

html=requests.get(url).text

html=html.replace("window.baidu.sug(",'')

html = html.replace(")",'')

html = html.replace(";",'')

#print(html)

html = json.loads(html)

key_words=html['s']

#print(key_words)

返回key_wordscopy代码

本质上第二个和第三个性质是一样的,我们参考使用吧!

扩展版:这里有个小技巧,就是在关键词后输入w,会出现拼音中w开头的一系列关键词,比如“黄山w”,“黄山温泉”会出现出现,“黄山”玩几天”,“黄山五绝”等等关键词(见上面截图)。因此,当我们遍历a~z时,会出现更多的关键词。 def get_more_word(word ):

more_word=[]

for i in'abcdefghijklmnopqrstuvwxyz':

more_word.extend(get_keywords('%s%s'%(word,i)))

打印(more_word)

打印(len(more_word))

打印(len(list(set(more_word))))

返回列表(set(more_word))#去重操作

def get_more_sug(word):

all_words = []

for i in'abcdefghijklmnopqrstuvwxyz':

all_words += get_sug(word+i)# 遍历字母表 |使用之前的功能

print(len(list(set(all_words))))

return list(set(all_words))#复制代码重复

这里选择了版本2的接口形式,以免不协调。但是如果使用requests模块请求无效的网站,则会直接报错。您可以将 verify 参数设置为 False 来解决这个问题 r = requests.get(url, verify=False ) 但是设置 verify=False 会抛出 InsecureRequestWarning 警告。这看起来很糟糕。解决方案: from requests.packages.urllib3.exceptions import InsecureRequestWarning

#禁用安全请求警告

requests.packages.urllib3.disable_warnings(InsecureRequestWarning)复制代码

运行效果

为了方便大家使用和玩,本渣特为大家打包了低版本的exe工具,方便大家使用!获取百度网盘的exe工具

以下为exe下载信息,可回复!

访客,如果您想查看本帖隐藏内容,请回复

以上代码仅供参考!如果有效,请给个好评,谢谢! !

好评,谢谢! !

66666,值得学习

66666,值得学习

金币+1贡献+5

标签:采集源码解读关键词下拉框

转载:感谢您对Yudi Silent个人博客网站platform的认可,以及网站分享的经验、工具和文章。欢迎分享给您的个人站长或朋友圈,但转载请注明文章出处。

()

上一篇:“SEO工具”百度下拉框关键词无限裂变采集

下一个:111.206.221.*谁知道这个IP段是什么?我一直在扫描我的网站

关键词文章采集源码(上篇分享文章:vuex-源码分享:第二篇(组图))

采集交流 • 优采云 发表了文章 • 0 个评论 • 145 次浏览 • 2021-09-04 14:07

关键词文章采集源码架构分享分享一次分享的架构源码/解释源码架构师:参与过页面埋点,跟踪页面更新。以及少数值得分享的架构分享文章。其中「vue-mining」分享源码我挑选第一篇文章开讲。上篇分享文章:vuex源码分享:第二篇(本文发布时间:2018年12月21日)--本节分享视频教程:vue.js-mining通过在vue项目中使用vuex,提升了我们页面的可维护性(es6规范的扩展性,开发效率高)在vue中使用vuexvuex是vue项目中的一个用于构建状态管理系统的库,vuex可以帮助我们在运行中的vue中很好的处理状态变更,通过vuex的生命周期机制,当test执行完后我们可以在配置执行submit更新当前状态。

同时也可以通过submit,来执行全局的所有props/constants变更。具体架构分享视频教程:-vuex-源码分享/合集推荐/视频公开/免费分享出处:vue-mining/vuex合集源码分享vuex源码合集视频教程,希望大家喜欢vuexvuex源码合集源码分享ueq,对于vue相关问题的回答———更多源码分享(日更):。

vue-mining发布了一个vuex源码合集,包含了大部分vuex相关源码的修改和分析,包括作用域模型,依赖注入,路由相关等,而且还会结合delicious生产环境和vuexfunction()方法分析。快快看吧。 查看全部

关键词文章采集源码(上篇分享文章:vuex-源码分享:第二篇(组图))

关键词文章采集源码架构分享分享一次分享的架构源码/解释源码架构师:参与过页面埋点,跟踪页面更新。以及少数值得分享的架构分享文章。其中「vue-mining」分享源码我挑选第一篇文章开讲。上篇分享文章:vuex源码分享:第二篇(本文发布时间:2018年12月21日)--本节分享视频教程:vue.js-mining通过在vue项目中使用vuex,提升了我们页面的可维护性(es6规范的扩展性,开发效率高)在vue中使用vuexvuex是vue项目中的一个用于构建状态管理系统的库,vuex可以帮助我们在运行中的vue中很好的处理状态变更,通过vuex的生命周期机制,当test执行完后我们可以在配置执行submit更新当前状态。

同时也可以通过submit,来执行全局的所有props/constants变更。具体架构分享视频教程:-vuex-源码分享/合集推荐/视频公开/免费分享出处:vue-mining/vuex合集源码分享vuex源码合集视频教程,希望大家喜欢vuexvuex源码合集源码分享ueq,对于vue相关问题的回答———更多源码分享(日更):。

vue-mining发布了一个vuex源码合集,包含了大部分vuex相关源码的修改和分析,包括作用域模型,依赖注入,路由相关等,而且还会结合delicious生产环境和vuexfunction()方法分析。快快看吧。

关键词文章采集源码(市面上采集器那么多,应该用哪个好?(图))

采集交流 • 优采云 发表了文章 • 0 个评论 • 140 次浏览 • 2021-09-04 08:08

原创好还是采集好?

当然是原创好,因为百度这么说,谁是裁判。

为什么我原创有很多文章,但还是没有收录?收录没有排名?

一个搜索引擎,其核心价值是为用户提供他/她最需要的结果。搜索引擎对网民的需求有统计。对于网民需求很少或几乎没有的内容,即使你是原创,也可能会被搜索引擎忽略,因为它不想在无意义的内容上浪费资源。

对于网民需求量很大的内容,收录应该更多更快。不过因为收录多,就算你是原创,也可能很难挤进排名。

搜索引擎统计中对网民需求的识别是什么?

关键词。当每个人搜索一个关键词时,就表明他/她对与该词相关的内容有需求。而且,使用搜索引擎的人通常会有问答和搜索查询。当然,搜索引擎内部必须有一个非常庞大的分析系统,才能准确定位这些需求。详见百度指数。例如,搜索到的关键词 是“手机”。很有可能你想买一部手机或查看某个型号的价格,或者你可能只是想下载一张漂亮的壁纸。但是,如果你想要壁纸,会有更准确的关键词“手机壁纸”,会以下拉框或相关搜索的形式显示。

既然原创好,为什么采集?

1.原创虽然不错,但只要方法得当,采集的效果不会比原创差多少,甚至比那些没有掌握的原创还要好方法。

2. 能量有限。 原创很难保证长期大量更新。如果你问编辑,投入产出比可能是负数。

市面上采集器那么多,我该用哪个?

每个采集器 都有自己的独特性。所谓存在就是合理。请根据您的需要选择。我的采集器 是我自己开发的。在开发过程中考虑了以下几个方面。其他采集器也可以作为参考:

1.直接提供了大量分类的关键词,这些关键词是百度统计过的有网友需求的词(有百度指数),或者这些词的长尾词,来自百度下拉框或相关搜索。

2.直接按关键词采集,智能分析网页正文进行抓取,无需自己编写采集规则。

3.捕获的文字已经用标准标签清理过,所有段落都标有

标签显示,乱码全部去掉。

4.根据采集收到的内容,自动配置图片。图像必须与内容非常相关。这样替换伪原创既不会影响可读性,也能让文章图文比原创提供的信息更丰富。

正文内容中的5.关键词自动加粗,插入的关键词也可以自定义。但是没有所谓的“伪原创”功能影响可读性,比如句子重排、段落重排。

6.可以直接使用关键词及其相关词的组合作为标题,或者抓取目标页面的标题。

7.可以是微信文章采集。

8.无需触发或挂断。

9.整合百度站长平台主动推送,加速收录。

不同的网站程序,如织梦、WordPress、dz、zblog、Empirecms等,对SEO有什么影响?

理论上没有影响。因为搜索引擎不知道你是什么程序,或者可以通过一些规则来识别,所以程序本身不可能影响它的判断。

那么什么会影响搜索引擎优化?答案是模板。因为基本上这些程序都有模板机制,同一个程序可以输出不同的页面,不同的程序也可以输出同一个页面。这是一个模板。模板确定后,你的每个页面都会按照这个框架输出,也就是整个html结构就确定了。而这些html正是搜索引擎应该关注的,它要从这些html中获取自己想要的信息。因此,一套好的模板非常重要。

模板设计需要注意哪些细节?

1. 权重结构的顺序。在整个页面的html中(注意是html,不是显示的布局),位置越高权重越高。推而广之,“title”、keyword、description这三个标签的权重最高,因为它们是最高级的。其次通常是导航,基本上是最高的,权重也很高。再次,文章 标题和正文。这是按照html的前后排序。

2. 因为搜索引擎首先要遵循W3C标准,所以W3C定义的一些标签本来是用来表示重要信息的,权重自然就高一些,比如特别是h1,用来表示最重要的信息当前页面的信息 一般情况下,每页只能有一个信息。权重估计相当于标题,一般用来放置当前页面的标题。当然,为了增加首页的权重,可以使用h1来放置logo或者首页链接。另外还有em、strong等标签,用来表示强调。一般认为强权重高于标签,这也是一个大胆的效果,但我们认为从SEO的角度来看没有权重提升。

3. css 或 js 代码通常对搜索引擎没有意义,尽量使用单独的文件来存储,或者在允许的情况下放在 html 的末尾

网站结构规划应注意哪些问题?

1. URL 设计。 URL 也可以收录关键词。比如你的网站是关于电脑的,你的网址可以收录“PC”,因为它在搜索引擎眼中通常是“电脑”的同义词。网址不要太长,级别不要超过4级。

2. 栏目设计。列通常与导航相关联。设计时要考虑网站的整体主题。用户可能感兴趣的内容。列名最好是网站的几个主要关键词,这样也方便导航。的重量。

3.关键词layout。理论上,每个内容页都应该在同一栏目下有自己的核心关键词、文章,并尽可能围绕关键词栏目展开。一个简单粗暴的做法就是直接用关键词列的长尾词。

动态、伪静态、静态,三者哪个更好?

这个不能一概而论,建议使用伪静态或者静态。三者的区别在于是否生成静态文件和URL格式是否为动态。生成静态文件本质上是为了加快访问速度,减少数据库查询,但是会不断增加占用的空间;伪静态只是通过URL重写来修改URL,其实每次还是需要经过程序计算,查询数据库,输出页面。对加快访问速度完全无效。动态和伪静态的唯一区别是网址,带问号和参数。

所以只注意两点:网站打开速度够快吗?您需要节省服务器空间吗?

不同的网站程序可能有不同的数据库操作效率。一般来说,如果内容页数小于10000,则页面打开速度比较快,数据量较大,达到50000、100000甚至更多,通常会考虑静态化。

提高访问速度的方法有哪些?

1. 上面已经提到的静态化。

2. 通常很多网站 模板都会随机调用文章 或类似的部分。事实上,随机性对数据库来说是一个更重的负担。模板中的随机文章应该被最小化。 @的电话。如果不可避免,请考虑从数据库进行优化。使用索引对字段进行排序通常比不使用索引要快得多。

3. 把不经常修改的图片、js、css等文件放在专用的静态服务器上。如果可以合并多个js或css,尽量合并成一个文件,减少http连接数。

4. 使用各种云加速产品。普通的网站,免费百度云加速或者360云加速都可以。

更多文章,网站开启了静态,但是整个站点更新时间很长,怎么办?

我的方法是使用缓存机制。我在这里只提供一个想法,可能需要我自己开发。

网站 设置为伪静态。当每个请求到达时,程序会检查是否有相应的缓存 html 文件。如果文件是在几小时或几天前生成的,我们确定它需要更新。此时执行正常流程,程序查询数据库,生成html,写入缓存文件,然后输出到客户端。

下次访问到来时,比如1分钟后再次访问同一页面,再次查看缓存文件时间。从时间就可以判断文件很新,完全不需要更新,直接读取文件内容输出到客户端。这样每个页面都可以自动生成,只有第一个访问者会觉得慢,后面的访问就相当于静态访问,速度非常快。

如果是单机服务器,也可以考虑自动检测服务器负载。如果负载已经很高,则判断需要更新,暂不更新。而是直接输出。

图片应该引用远程URL还是放在自己的服务器上?

这也有其自身的优点和缺点。引用远程URL可以节省自己的带宽,但是很可能是因为对方服务器慢,或者资源被删除,或者防盗链接导致图片无法显示。如果你下载到自己的服务器,当然一切都在你自己的掌控之中,但是图片会占用很多空间,并且可能比生成的静态占用更多的空间。并且如果流量很大,图片是最需要带宽的。

网站内链应该如何优化?

内链是百度官方推荐的优化方式之一,所以这个是必须要做的。通常的表现形式是文中出现某个关键词,在这个关键词上加了一个链接,指向另一个恰好与这个关键词相关的页面。于是,诞生了一些所谓的优化技巧,强行在文中插入一些关键词和链接,进行类似相互推送的操作。其他人,为了增加首页的权重,到处放网站名字,并链接到首页,认为这样可以增加目标页面的权重。但这些很可能适得其反,因为搜索引擎会计算每个链接的点击率。如果您点击突出显示但很少点击的链接,它们可能会被判断为作弊。因此,请只做文中已有的关键词内部链接。

段落重排、句子重排、同义词替换等伪原创技术好吗?

不好。因为搜索引擎已经智能,不再是简单的数据库搜索。它将执行自然语义分析(有关详细信息,请搜索“NLP”)。任何语义分析困难的句子或段落都可以判断为可读性差,所以我认为这些“伪原创”可能很聪明。

评论模块基本没用过,到底要不要做?

是的。评论模块最麻烦的就是垃圾评论。通常真正说话的访问者很少,垃圾评论也很多。他们整天与营销软件作斗争。这是我已经实现的解决方案,可能对收录有帮助(没有依据,只是猜测):

保留评论框,但禁用评论。所有评论均由我的网站 程序生成。如前所述,搜索引擎会进行自然语义分析。重要的能力之一是情绪判断。搜索引擎会计算每条评论的情感值,无论是正面的还是负面的,具体倾向是10%还是90%。如果评论的内容表达了积极的情绪,您可以在文本中加分,反之亦然。至于如何自动生成好评,就让八仙渡海各显神通吧。

这是社交网络发展后的必然趋势。这样,它就反映了一个页面的用户体验。同理,还有分享、点赞等,原理类似。

绿萝卜算法之后,有没有外链的用处?

有用。参见搜索引擎三定律的相关定律。既然是法律,就不会改变。谁的内容被引用得越多,就是权威。在主动推送出现之前,外链应该被视为蜘蛛识别页面内容的第一个渠道。

外部链接必须是锚文本还是裸链接?

没有。搜索引擎肩负着发现真正有价值的内容并排除那些没有价值的内容的重大责任。所以有可能你直接提交的链接不是收录,你可以直接在别人的地方发一个纯文本的URL。如果找到了,也算加分。

除了锚文本和裸链接,你还可以以关键词+ URL的形式发送纯文本。这样URL前面的关键词就自动和URL关联起来了。

另外,虽然有些链接添加了nofollow属性,但是百度计算外链的时候还是会计算的。

收录和索引有什么关系?

收录 表示蜘蛛已经爬取并分析过了。该指标表示蜘蛛分析后认为该内容具有一定的价值。只有进入索引的内容才会出现在搜索结果中,并显示给用户。换句话说,只有被索引的内容才有机会带来流量。 查看全部

关键词文章采集源码(市面上采集器那么多,应该用哪个好?(图))

原创好还是采集好?

当然是原创好,因为百度这么说,谁是裁判。

为什么我原创有很多文章,但还是没有收录?收录没有排名?

一个搜索引擎,其核心价值是为用户提供他/她最需要的结果。搜索引擎对网民的需求有统计。对于网民需求很少或几乎没有的内容,即使你是原创,也可能会被搜索引擎忽略,因为它不想在无意义的内容上浪费资源。

对于网民需求量很大的内容,收录应该更多更快。不过因为收录多,就算你是原创,也可能很难挤进排名。

搜索引擎统计中对网民需求的识别是什么?

关键词。当每个人搜索一个关键词时,就表明他/她对与该词相关的内容有需求。而且,使用搜索引擎的人通常会有问答和搜索查询。当然,搜索引擎内部必须有一个非常庞大的分析系统,才能准确定位这些需求。详见百度指数。例如,搜索到的关键词 是“手机”。很有可能你想买一部手机或查看某个型号的价格,或者你可能只是想下载一张漂亮的壁纸。但是,如果你想要壁纸,会有更准确的关键词“手机壁纸”,会以下拉框或相关搜索的形式显示。

既然原创好,为什么采集?

1.原创虽然不错,但只要方法得当,采集的效果不会比原创差多少,甚至比那些没有掌握的原创还要好方法。

2. 能量有限。 原创很难保证长期大量更新。如果你问编辑,投入产出比可能是负数。

市面上采集器那么多,我该用哪个?

每个采集器 都有自己的独特性。所谓存在就是合理。请根据您的需要选择。我的采集器 是我自己开发的。在开发过程中考虑了以下几个方面。其他采集器也可以作为参考:

1.直接提供了大量分类的关键词,这些关键词是百度统计过的有网友需求的词(有百度指数),或者这些词的长尾词,来自百度下拉框或相关搜索。

2.直接按关键词采集,智能分析网页正文进行抓取,无需自己编写采集规则。

3.捕获的文字已经用标准标签清理过,所有段落都标有

标签显示,乱码全部去掉。

4.根据采集收到的内容,自动配置图片。图像必须与内容非常相关。这样替换伪原创既不会影响可读性,也能让文章图文比原创提供的信息更丰富。

正文内容中的5.关键词自动加粗,插入的关键词也可以自定义。但是没有所谓的“伪原创”功能影响可读性,比如句子重排、段落重排。

6.可以直接使用关键词及其相关词的组合作为标题,或者抓取目标页面的标题。

7.可以是微信文章采集。

8.无需触发或挂断。

9.整合百度站长平台主动推送,加速收录。

不同的网站程序,如织梦、WordPress、dz、zblog、Empirecms等,对SEO有什么影响?

理论上没有影响。因为搜索引擎不知道你是什么程序,或者可以通过一些规则来识别,所以程序本身不可能影响它的判断。

那么什么会影响搜索引擎优化?答案是模板。因为基本上这些程序都有模板机制,同一个程序可以输出不同的页面,不同的程序也可以输出同一个页面。这是一个模板。模板确定后,你的每个页面都会按照这个框架输出,也就是整个html结构就确定了。而这些html正是搜索引擎应该关注的,它要从这些html中获取自己想要的信息。因此,一套好的模板非常重要。

模板设计需要注意哪些细节?

1. 权重结构的顺序。在整个页面的html中(注意是html,不是显示的布局),位置越高权重越高。推而广之,“title”、keyword、description这三个标签的权重最高,因为它们是最高级的。其次通常是导航,基本上是最高的,权重也很高。再次,文章 标题和正文。这是按照html的前后排序。

2. 因为搜索引擎首先要遵循W3C标准,所以W3C定义的一些标签本来是用来表示重要信息的,权重自然就高一些,比如特别是h1,用来表示最重要的信息当前页面的信息 一般情况下,每页只能有一个信息。权重估计相当于标题,一般用来放置当前页面的标题。当然,为了增加首页的权重,可以使用h1来放置logo或者首页链接。另外还有em、strong等标签,用来表示强调。一般认为强权重高于标签,这也是一个大胆的效果,但我们认为从SEO的角度来看没有权重提升。

3. css 或 js 代码通常对搜索引擎没有意义,尽量使用单独的文件来存储,或者在允许的情况下放在 html 的末尾

网站结构规划应注意哪些问题?

1. URL 设计。 URL 也可以收录关键词。比如你的网站是关于电脑的,你的网址可以收录“PC”,因为它在搜索引擎眼中通常是“电脑”的同义词。网址不要太长,级别不要超过4级。

2. 栏目设计。列通常与导航相关联。设计时要考虑网站的整体主题。用户可能感兴趣的内容。列名最好是网站的几个主要关键词,这样也方便导航。的重量。

3.关键词layout。理论上,每个内容页都应该在同一栏目下有自己的核心关键词、文章,并尽可能围绕关键词栏目展开。一个简单粗暴的做法就是直接用关键词列的长尾词。

动态、伪静态、静态,三者哪个更好?

这个不能一概而论,建议使用伪静态或者静态。三者的区别在于是否生成静态文件和URL格式是否为动态。生成静态文件本质上是为了加快访问速度,减少数据库查询,但是会不断增加占用的空间;伪静态只是通过URL重写来修改URL,其实每次还是需要经过程序计算,查询数据库,输出页面。对加快访问速度完全无效。动态和伪静态的唯一区别是网址,带问号和参数。

所以只注意两点:网站打开速度够快吗?您需要节省服务器空间吗?

不同的网站程序可能有不同的数据库操作效率。一般来说,如果内容页数小于10000,则页面打开速度比较快,数据量较大,达到50000、100000甚至更多,通常会考虑静态化。

提高访问速度的方法有哪些?

1. 上面已经提到的静态化。

2. 通常很多网站 模板都会随机调用文章 或类似的部分。事实上,随机性对数据库来说是一个更重的负担。模板中的随机文章应该被最小化。 @的电话。如果不可避免,请考虑从数据库进行优化。使用索引对字段进行排序通常比不使用索引要快得多。

3. 把不经常修改的图片、js、css等文件放在专用的静态服务器上。如果可以合并多个js或css,尽量合并成一个文件,减少http连接数。

4. 使用各种云加速产品。普通的网站,免费百度云加速或者360云加速都可以。

更多文章,网站开启了静态,但是整个站点更新时间很长,怎么办?

我的方法是使用缓存机制。我在这里只提供一个想法,可能需要我自己开发。

网站 设置为伪静态。当每个请求到达时,程序会检查是否有相应的缓存 html 文件。如果文件是在几小时或几天前生成的,我们确定它需要更新。此时执行正常流程,程序查询数据库,生成html,写入缓存文件,然后输出到客户端。

下次访问到来时,比如1分钟后再次访问同一页面,再次查看缓存文件时间。从时间就可以判断文件很新,完全不需要更新,直接读取文件内容输出到客户端。这样每个页面都可以自动生成,只有第一个访问者会觉得慢,后面的访问就相当于静态访问,速度非常快。

如果是单机服务器,也可以考虑自动检测服务器负载。如果负载已经很高,则判断需要更新,暂不更新。而是直接输出。

图片应该引用远程URL还是放在自己的服务器上?

这也有其自身的优点和缺点。引用远程URL可以节省自己的带宽,但是很可能是因为对方服务器慢,或者资源被删除,或者防盗链接导致图片无法显示。如果你下载到自己的服务器,当然一切都在你自己的掌控之中,但是图片会占用很多空间,并且可能比生成的静态占用更多的空间。并且如果流量很大,图片是最需要带宽的。

网站内链应该如何优化?

内链是百度官方推荐的优化方式之一,所以这个是必须要做的。通常的表现形式是文中出现某个关键词,在这个关键词上加了一个链接,指向另一个恰好与这个关键词相关的页面。于是,诞生了一些所谓的优化技巧,强行在文中插入一些关键词和链接,进行类似相互推送的操作。其他人,为了增加首页的权重,到处放网站名字,并链接到首页,认为这样可以增加目标页面的权重。但这些很可能适得其反,因为搜索引擎会计算每个链接的点击率。如果您点击突出显示但很少点击的链接,它们可能会被判断为作弊。因此,请只做文中已有的关键词内部链接。

段落重排、句子重排、同义词替换等伪原创技术好吗?

不好。因为搜索引擎已经智能,不再是简单的数据库搜索。它将执行自然语义分析(有关详细信息,请搜索“NLP”)。任何语义分析困难的句子或段落都可以判断为可读性差,所以我认为这些“伪原创”可能很聪明。

评论模块基本没用过,到底要不要做?

是的。评论模块最麻烦的就是垃圾评论。通常真正说话的访问者很少,垃圾评论也很多。他们整天与营销软件作斗争。这是我已经实现的解决方案,可能对收录有帮助(没有依据,只是猜测):

保留评论框,但禁用评论。所有评论均由我的网站 程序生成。如前所述,搜索引擎会进行自然语义分析。重要的能力之一是情绪判断。搜索引擎会计算每条评论的情感值,无论是正面的还是负面的,具体倾向是10%还是90%。如果评论的内容表达了积极的情绪,您可以在文本中加分,反之亦然。至于如何自动生成好评,就让八仙渡海各显神通吧。

这是社交网络发展后的必然趋势。这样,它就反映了一个页面的用户体验。同理,还有分享、点赞等,原理类似。

绿萝卜算法之后,有没有外链的用处?

有用。参见搜索引擎三定律的相关定律。既然是法律,就不会改变。谁的内容被引用得越多,就是权威。在主动推送出现之前,外链应该被视为蜘蛛识别页面内容的第一个渠道。

外部链接必须是锚文本还是裸链接?

没有。搜索引擎肩负着发现真正有价值的内容并排除那些没有价值的内容的重大责任。所以有可能你直接提交的链接不是收录,你可以直接在别人的地方发一个纯文本的URL。如果找到了,也算加分。

除了锚文本和裸链接,你还可以以关键词+ URL的形式发送纯文本。这样URL前面的关键词就自动和URL关联起来了。

另外,虽然有些链接添加了nofollow属性,但是百度计算外链的时候还是会计算的。

收录和索引有什么关系?

收录 表示蜘蛛已经爬取并分析过了。该指标表示蜘蛛分析后认为该内容具有一定的价值。只有进入索引的内容才会出现在搜索结果中,并显示给用户。换句话说,只有被索引的内容才有机会带来流量。

关键词文章采集源码( PHP仿代下狗源码-素材代下载系统打包介绍)

采集交流 • 优采云 发表了文章 • 0 个评论 • 163 次浏览 • 2021-09-04 01:20

PHP仿代下狗源码-素材代下载系统打包介绍)

PHP仿生狗源码-素材生成下载搜索引擎系统整站打包

简介:PHP仿生狗源码-素材下载搜索引擎系统多功能/自带优采云采集界面/源码付费下载系统/全站打包完美运行版缺点:此用户登录必须是连接QQ上网登录,如果有能力自己注册登录1、使用的是php+mysql全新框架,百度没有抓到,所以收录效果和加权效果没有话不多说2、mysql数据库,可以自己导入关键词,可以根据自己的行业导入3、,设置重点推送自己的行业词,避免收录无关关键词4、集成用户界面...

首席赚钱存钱专家小程序1.5.8+前端

简介:首席赚钱小程序源码单版专家1.5.8 有前后端,站长测试源码安装和后端功能设置并正常保存,前端- end 似乎并没有呼唤需要它的自己 下载并研究它。修复前后端产品展示和搜索问题。 关键词 显示异常问题。首席省钱小程序源码更新介绍:版本号:1.5.8-赚钱榜开通本次更新必填** *上传小程序审核 如果还有其他问题,请及时联系客服帮您处理后台小程序设置-其他设置-首页商品列表布局重置1....

PHP轻量级搜狗pan站群源码+符合搜狗算法

简介:轻量级PHP搜狗pan站群程序源码,完美符合搜狗搜索引擎算法的SEO优化,不加采集,只放关键词。绝对是八屏搜狗盘站群程序的超级强大源代码。这套源代码在某站卖12000元:这套站群源代码是聚合搜索后建模的,为搜狗搜索程序源代码,安装源代码后,修改关键词和你的域要使用的名称!程序采用入口代码跳转,摒弃了之前的JS跳转方式,更加方便灵活。跳转模板,可以自定义模板样式。入口判断是否来自搜狗搜索,如果来自搜...

夏日凉粉网站源源

听说这是前段时间最热门的抖音spots 之一。应该有利于排水。使用教程:源码编译完成后,将源码放在网站root目录下即可访问修改版权:修改index.acd45c96.js和vendor.a8b05719.js at index.acd45c96.中在assets文件夹@js中,可以修改页面顶部的文字,在vendor.a8b05719.js中搜索关键词“夏日清凉小风扇”

Zblog 二开WAP网站轻导航网站template

简介:导航输出设置:收录网站 站点:新文章 titled 网站title; 网站url 是网站 URL(URL 不能收录 http/https);由站长QQ填写站长QQ号; 网站LOGO 填写网站的LOGO链接(URL需为http/https),标签为网站关键词。 (发文章不需要填写网站url/qq/logo,留空即可,文章标签会保存为原标签)模板seo设置:文章内页(文章title-category Name-site name) 内导航页(收录网站名-接收...

百度爬虫页面自动复制程序+教程自动SEO优化

简介:这是一个自动复制百度爬虫页面的泛目录程序。附视频教程1、只采集关键词,无需更新任何文章,内容2、页面自动复制,自动SEO优化3、asp脚本伪静态无限生成4、自动抓取百度的关键词Results and Titles5、 根据关键词,自动抓取百度搜索结果页面标题+摘要6、页面内链随机插入。页面站点地图随机称为3007、。只需要一个老域名,没有灰色历史,有网站历史8、页面可读性强,搜狗效果更好,流量来得更快...

BYR-Navi-master 好看有个性网站technical 导航源码

网站基于Fomantic UI Web框架,整个项目的设计和构建具有高度的配置和定制灵活性。整体风格比较适合个人导航网站。使用搜索框输入关键词后,点击上方搜索引擎图标即可跳转到对应的搜索引擎搜索结果,使用起来非常方便快捷。有关详细信息,请参阅屏幕截图。整个项目的设计和施工具有高度的配置和定制灵活性。可以通过修改_config.yml文件进行配置,也可以将*.yml文件的_data文件夹中的文件内容替换为自己的数据...

新版SEO每日扣分系统_SEO扣分系统源码_关键词rank监控_网站rank监控工具/ThinkPHP内核

新版SEO每日扣费系统_SEO扣费系统源码_关键词rank监控_网站rank监控工具/ThinkPHP内核功能介绍:1、会员管理:系统分为三级会员流程总部管理员、代理、会员(会员分为普通会员、中级会员、高级会员三级)。总部增加代理用户,为代理用户充值余额,为普通用户充值余额,代理还可以给3级会员增加关键词的查询率。如果这个关键词总站代理10元,普通用户的代理费率是200%,...

matomo网站Access 统计流量统计系统源码 v3.13.1

matomo网站统计系统(原名Piwik)是一个基于PHP5+MySQL技术的开源网站访问统计系统,原名phpMyVisites。 Piwik可以为您提供详细的统计信息,如网页访问量、访问量最大的页面、搜索引擎关键词等流量分析功能。此外,它还采用了插件扩展和开放的API架构,让用户可以根据自己的实际需求创建更多的功能。同时,作为开源项目软件,Piwik 也鼓励开发者扩展和增强其功能,...

Blog自媒体platform 风格主题 | WordPress

主题特点:自适应布局,完美兼容手机和电脑终端。高度可定制的主题设置(徽标、网站图标、幻灯片、底部导航、网站 公告等)显示在背景中。丰富的站点基础优化(头部简化)代码,去除类别,文章外链自动添加nofollow,Tag标签自动添加内链,图片自动添加alt,自动添加现有关键词等...)自定义颜色(目前只有导航自定义颜色,以后会添加更多)自定义封面高度大小自定义设置文章默认缩略图主页,文章... 查看全部

关键词文章采集源码(

PHP仿代下狗源码-素材代下载系统打包介绍)

PHP仿生狗源码-素材生成下载搜索引擎系统整站打包

简介:PHP仿生狗源码-素材下载搜索引擎系统多功能/自带优采云采集界面/源码付费下载系统/全站打包完美运行版缺点:此用户登录必须是连接QQ上网登录,如果有能力自己注册登录1、使用的是php+mysql全新框架,百度没有抓到,所以收录效果和加权效果没有话不多说2、mysql数据库,可以自己导入关键词,可以根据自己的行业导入3、,设置重点推送自己的行业词,避免收录无关关键词4、集成用户界面...

首席赚钱存钱专家小程序1.5.8+前端

简介:首席赚钱小程序源码单版专家1.5.8 有前后端,站长测试源码安装和后端功能设置并正常保存,前端- end 似乎并没有呼唤需要它的自己 下载并研究它。修复前后端产品展示和搜索问题。 关键词 显示异常问题。首席省钱小程序源码更新介绍:版本号:1.5.8-赚钱榜开通本次更新必填** *上传小程序审核 如果还有其他问题,请及时联系客服帮您处理后台小程序设置-其他设置-首页商品列表布局重置1....

PHP轻量级搜狗pan站群源码+符合搜狗算法

简介:轻量级PHP搜狗pan站群程序源码,完美符合搜狗搜索引擎算法的SEO优化,不加采集,只放关键词。绝对是八屏搜狗盘站群程序的超级强大源代码。这套源代码在某站卖12000元:这套站群源代码是聚合搜索后建模的,为搜狗搜索程序源代码,安装源代码后,修改关键词和你的域要使用的名称!程序采用入口代码跳转,摒弃了之前的JS跳转方式,更加方便灵活。跳转模板,可以自定义模板样式。入口判断是否来自搜狗搜索,如果来自搜...

夏日凉粉网站源源

听说这是前段时间最热门的抖音spots 之一。应该有利于排水。使用教程:源码编译完成后,将源码放在网站root目录下即可访问修改版权:修改index.acd45c96.js和vendor.a8b05719.js at index.acd45c96.中在assets文件夹@js中,可以修改页面顶部的文字,在vendor.a8b05719.js中搜索关键词“夏日清凉小风扇”

Zblog 二开WAP网站轻导航网站template

简介:导航输出设置:收录网站 站点:新文章 titled 网站title; 网站url 是网站 URL(URL 不能收录 http/https);由站长QQ填写站长QQ号; 网站LOGO 填写网站的LOGO链接(URL需为http/https),标签为网站关键词。 (发文章不需要填写网站url/qq/logo,留空即可,文章标签会保存为原标签)模板seo设置:文章内页(文章title-category Name-site name) 内导航页(收录网站名-接收...

百度爬虫页面自动复制程序+教程自动SEO优化

简介:这是一个自动复制百度爬虫页面的泛目录程序。附视频教程1、只采集关键词,无需更新任何文章,内容2、页面自动复制,自动SEO优化3、asp脚本伪静态无限生成4、自动抓取百度的关键词Results and Titles5、 根据关键词,自动抓取百度搜索结果页面标题+摘要6、页面内链随机插入。页面站点地图随机称为3007、。只需要一个老域名,没有灰色历史,有网站历史8、页面可读性强,搜狗效果更好,流量来得更快...

BYR-Navi-master 好看有个性网站technical 导航源码

网站基于Fomantic UI Web框架,整个项目的设计和构建具有高度的配置和定制灵活性。整体风格比较适合个人导航网站。使用搜索框输入关键词后,点击上方搜索引擎图标即可跳转到对应的搜索引擎搜索结果,使用起来非常方便快捷。有关详细信息,请参阅屏幕截图。整个项目的设计和施工具有高度的配置和定制灵活性。可以通过修改_config.yml文件进行配置,也可以将*.yml文件的_data文件夹中的文件内容替换为自己的数据...

新版SEO每日扣分系统_SEO扣分系统源码_关键词rank监控_网站rank监控工具/ThinkPHP内核

新版SEO每日扣费系统_SEO扣费系统源码_关键词rank监控_网站rank监控工具/ThinkPHP内核功能介绍:1、会员管理:系统分为三级会员流程总部管理员、代理、会员(会员分为普通会员、中级会员、高级会员三级)。总部增加代理用户,为代理用户充值余额,为普通用户充值余额,代理还可以给3级会员增加关键词的查询率。如果这个关键词总站代理10元,普通用户的代理费率是200%,...

matomo网站Access 统计流量统计系统源码 v3.13.1

matomo网站统计系统(原名Piwik)是一个基于PHP5+MySQL技术的开源网站访问统计系统,原名phpMyVisites。 Piwik可以为您提供详细的统计信息,如网页访问量、访问量最大的页面、搜索引擎关键词等流量分析功能。此外,它还采用了插件扩展和开放的API架构,让用户可以根据自己的实际需求创建更多的功能。同时,作为开源项目软件,Piwik 也鼓励开发者扩展和增强其功能,...

Blog自媒体platform 风格主题 | WordPress

主题特点:自适应布局,完美兼容手机和电脑终端。高度可定制的主题设置(徽标、网站图标、幻灯片、底部导航、网站 公告等)显示在背景中。丰富的站点基础优化(头部简化)代码,去除类别,文章外链自动添加nofollow,Tag标签自动添加内链,图片自动添加alt,自动添加现有关键词等...)自定义颜色(目前只有导航自定义颜色,以后会添加更多)自定义封面高度大小自定义设置文章默认缩略图主页,文章...

关键词文章采集源码(爬虫符源码:使用循环以及自身循环访问网页获取数据 )

采集交流 • 优采云 发表了文章 • 0 个评论 • 129 次浏览 • 2021-09-02 22:03

)

想找图的朋友不要错过这个网站,对对对,就是。各种图都有,推荐的画板里的字还是很不错的。不幸的是,它有很多和谐。如果要采集玫瑰画板的话,python爬虫当然没问题,花瓣数据更有趣!

查询源码,有点类似数据接口

app.page["explores"] = [{"keyword_id":1541, "name":"创意灯", "urlname":"创益登居", "cover":{"farm":"farm1", "bucket":"hbimg", "key":"f77b1c1df184ce91ff529a4d0b5211aa883872c91345f-tdQn2g", "type":"image/jpeg", "width":468, "height":702":", "frame" 15723730},“

想了想,用常规获取更简单方便!

常规

explores=re.findall(r'app.page\["explores"\] = \[(.+?)\];.+?app.page\["followers"\]',html,re.S)[0]

这里需要注意转义符

源代码:

#花瓣推荐画报词采集

#20200314 by 微信:huguo00289

# -*- coding: UTF-8 -*-

from fake_useragent import UserAgent

import requests,re,time

from csql import Save

key_informations=[]

def search(key,keyurl):

print(f"正在查询: {key}")

ua = UserAgent()

headers = {"User-Agent": ua.random}

url=f"https://huaban.com/explore/{keyurl}/"

html=requests.get(url,headers=headers).content.decode("utf-8")

time.sleep(2)

if 'app.page["category"]' in html:

#print(html)

explores=re.findall(r'app.page\["explores"\] = \[(.+?)\];.+?app.page\["followers"\]',html,re.S)[0]

#print(explores)

keyfins=re.findall(r', "name":"(.+?)", "urlname":"(.+?)",',explores,re.S)

print(keyfins)

sa=Save(keyfins)

sa.sav()

for keyfin in keyfins:

if keyfin not in key_informations:

key_informations.append(keyfin)

search(keyfin[0], keyfin[1])

print(len(key_informations))

else:

print(f"查询关键词{key}不是工业设计分类,放弃查询!")

pass

print(len(key_informations))

print(key_informations)

search('3D打印', '3dp')

函数调用自身,不断循环到网页获取数据!

花网画板字采集

数据是下拉加载,ajax数据加载

同时有个规律,就是下一个下拉max就是最后一个花瓣seq!

源代码:

#花瓣画报词采集

#20200320 by 微信:huguo00289

# -*- coding: UTF-8 -*-

from csql import Save

import requests,json,time

def get_board(id):

headers={

'Cookie': 'UM_distinctid=170c29e8d8f84f-0b44fc835bc8e3-43450521-1fa400-170c29e8d903de; CNZZDATA1256914954=1367860536-1583810242-null%7C1583837292; _uab_collina=158415646085953266966037; __auc=30586f3f170d7154a5593583b24; __gads=ID=28115786a916a7a1:T=1584156505:S=ALNI_MbtohAUwMbbd5Yoa5OBBaSO0tSJkw; _hmt=1; sid=s%3AkwSz9iaMxZf-XtcJX9rrY4ltNDbqkeYs.bc8fvfAq6DLGxsRQ6LF9%2FmHcjOGIhRSZC0RkuKyHd7w; referer=https%3A%2F%2Fwww.baidu.com%2Flink%3Furl%3Df1FbGruB8SzQQxEDyaJ_mefz-bVnJFZJaAcQYJGXTZq%26wd%3D%26eqid%3Dda22ff4e0005f208000000065e74adf2; uid=29417717; _f=iVBORw0KGgoAAAANSUhEUgAAADIAAAAUCAYAAADPym6aAAABJ0lEQVRYR%2B1VuxHCMAyVFqKjomEjVgkb0VDRMQgrmJMdBcUn2VbAXDiSJpb9%2FHl6%2BiCEEAAAAiL9AJP5sgHSQuMXAOIB6NxXO354DOlhxodMhB8vicQxjgxrN4l1IrMRMRzmVkSeQ4pMIUdRp4RNaU4LsRzPNt9rKekmooWWDJVvjqVTuxKJeTWqJL1vkV2CZzJdifRWZ5EitfJrxbI2r6nEj8rxs5w08pAwLkXUgrGg%2FDoqdTN0IzK5ylAkXG6pgx%2F3sfPntuZqxsh9JUkk%2Fry7FtWbdXZvaNFFkgiPLRJyXe5txZfIbEQ4nMjLNe9K7FS9hJqrUeTnibQm%2BeoV0R5olZZctZqKGr5bsnuISPXy8muRssrv6X6AnNRbVau5LX8A%2BDed%2FQkRsJAorSTxBAAAAABJRU5ErkJggg%3D%3D%2CWin32.1920.1080.24; Hm_lvt_d4a0e7c3cd16eb58a65472f40e7ee543=1584330161,1584348316,1584516528,1584705015; __asc=c7dc256a170f7c78b1b2b6abc60; CNZZDATA1256903590=1599552095-1584151635-https%253A%252F%252Fwww.baidu.com%252F%7C1584704759; _cnzz_CV1256903590=is-logon%7Clogged-in%7C1584705067566%26urlname%7Cxpmvxxfddh%7C1584705067566; Hm_lpvt_d4a0e7c3cd16eb58a65472f40e7ee543=1584705067',

'Referer': 'https://huaban.com/discovery/i ... 27%3B,

'User-Agent': 'Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/69.0.3497.100 Safari/537.36',

'X-Request': 'JSON',

'X-Requested-With': 'XMLHttpRequest',

}

url="https://huaban.com/discovery/i ... ot%3B % id

html=requests.get(url,headers=headers,timeout=8).content.decode('utf-8')

time.sleep(1)

if html:

req=json.loads(html)

print(req)

boards=req['boards']

print(len(boards))

for board in boards:

print(board['title'])

sa = Save(board['title'])

sa.sav2()

#print(board['seq'])

next_id=boards[-1]['seq']

get_board(next_id)

if __name__ == '__main__':

id="1584416341304281760"

while True:

get_board(id)

使用while循环和自循环

最后保存到数据库

源代码

import pymysql

class Save(object):

def __init__(self,key):

self.host="localhost"

self.user="root"

self.password="123456"

self.db="xiaoshuo"

self.port=3306

self.connect = pymysql.connect(

host=self.host,

user=self.user,

password=self.password,

db=self.db,

port=self.port,

)

self.cursor = self.connect.cursor() # 设置游标

self.key=key

def insert(self):

for keyword in self.key:

try:

sql="INSERT INTO huaban(keyword)VALUES(%s)"

val = (keyword[0])

self.cursor.execute(sql, val)

self.connect.commit()

print(f'>>> 插入 {keyword[0]} 数据成功!')

except Exception as e:

print(e)

print(f'>>> 插入 {keyword[0]} 数据失败!')

def insert2(self):

keyword=self.key

try:

sql="INSERT INTO huaban2(keyword)VALUES(%s)"

val = keyword

self.cursor.execute(sql, val)

self.connect.commit()

print(f'>>> 插入 {keyword} 数据成功!')

except Exception as e:

print(e)

print(f'>>> 插入 {keyword} 数据失败!')

def cs(self):

# 关闭数据库

self.cursor.close()

self.connect.close()

def sav(self):

self.insert()

self.cs()

def sav2(self):

self.insert2()

self.cs() 查看全部

关键词文章采集源码(爬虫符源码:使用循环以及自身循环访问网页获取数据

)

想找图的朋友不要错过这个网站,对对对,就是。各种图都有,推荐的画板里的字还是很不错的。不幸的是,它有很多和谐。如果要采集玫瑰画板的话,python爬虫当然没问题,花瓣数据更有趣!

查询源码,有点类似数据接口

app.page["explores"] = [{"keyword_id":1541, "name":"创意灯", "urlname":"创益登居", "cover":{"farm":"farm1", "bucket":"hbimg", "key":"f77b1c1df184ce91ff529a4d0b5211aa883872c91345f-tdQn2g", "type":"image/jpeg", "width":468, "height":702":", "frame" 15723730},“

想了想,用常规获取更简单方便!

常规

explores=re.findall(r'app.page\["explores"\] = \[(.+?)\];.+?app.page\["followers"\]',html,re.S)[0]

这里需要注意转义符

源代码:

#花瓣推荐画报词采集

#20200314 by 微信:huguo00289

# -*- coding: UTF-8 -*-

from fake_useragent import UserAgent

import requests,re,time

from csql import Save

key_informations=[]

def search(key,keyurl):

print(f"正在查询: {key}")

ua = UserAgent()

headers = {"User-Agent": ua.random}

url=f"https://huaban.com/explore/{keyurl}/"

html=requests.get(url,headers=headers).content.decode("utf-8")

time.sleep(2)

if 'app.page["category"]' in html:

#print(html)

explores=re.findall(r'app.page\["explores"\] = \[(.+?)\];.+?app.page\["followers"\]',html,re.S)[0]

#print(explores)

keyfins=re.findall(r', "name":"(.+?)", "urlname":"(.+?)",',explores,re.S)

print(keyfins)

sa=Save(keyfins)

sa.sav()

for keyfin in keyfins:

if keyfin not in key_informations:

key_informations.append(keyfin)

search(keyfin[0], keyfin[1])

print(len(key_informations))

else:

print(f"查询关键词{key}不是工业设计分类,放弃查询!")

pass

print(len(key_informations))

print(key_informations)

search('3D打印', '3dp')

函数调用自身,不断循环到网页获取数据!

花网画板字采集

数据是下拉加载,ajax数据加载

同时有个规律,就是下一个下拉max就是最后一个花瓣seq!

源代码:

#花瓣画报词采集

#20200320 by 微信:huguo00289

# -*- coding: UTF-8 -*-

from csql import Save

import requests,json,time

def get_board(id):

headers={

'Cookie': 'UM_distinctid=170c29e8d8f84f-0b44fc835bc8e3-43450521-1fa400-170c29e8d903de; CNZZDATA1256914954=1367860536-1583810242-null%7C1583837292; _uab_collina=158415646085953266966037; __auc=30586f3f170d7154a5593583b24; __gads=ID=28115786a916a7a1:T=1584156505:S=ALNI_MbtohAUwMbbd5Yoa5OBBaSO0tSJkw; _hmt=1; sid=s%3AkwSz9iaMxZf-XtcJX9rrY4ltNDbqkeYs.bc8fvfAq6DLGxsRQ6LF9%2FmHcjOGIhRSZC0RkuKyHd7w; referer=https%3A%2F%2Fwww.baidu.com%2Flink%3Furl%3Df1FbGruB8SzQQxEDyaJ_mefz-bVnJFZJaAcQYJGXTZq%26wd%3D%26eqid%3Dda22ff4e0005f208000000065e74adf2; uid=29417717; _f=iVBORw0KGgoAAAANSUhEUgAAADIAAAAUCAYAAADPym6aAAABJ0lEQVRYR%2B1VuxHCMAyVFqKjomEjVgkb0VDRMQgrmJMdBcUn2VbAXDiSJpb9%2FHl6%2BiCEEAAAAiL9AJP5sgHSQuMXAOIB6NxXO354DOlhxodMhB8vicQxjgxrN4l1IrMRMRzmVkSeQ4pMIUdRp4RNaU4LsRzPNt9rKekmooWWDJVvjqVTuxKJeTWqJL1vkV2CZzJdifRWZ5EitfJrxbI2r6nEj8rxs5w08pAwLkXUgrGg%2FDoqdTN0IzK5ylAkXG6pgx%2F3sfPntuZqxsh9JUkk%2Fry7FtWbdXZvaNFFkgiPLRJyXe5txZfIbEQ4nMjLNe9K7FS9hJqrUeTnibQm%2BeoV0R5olZZctZqKGr5bsnuISPXy8muRssrv6X6AnNRbVau5LX8A%2BDed%2FQkRsJAorSTxBAAAAABJRU5ErkJggg%3D%3D%2CWin32.1920.1080.24; Hm_lvt_d4a0e7c3cd16eb58a65472f40e7ee543=1584330161,1584348316,1584516528,1584705015; __asc=c7dc256a170f7c78b1b2b6abc60; CNZZDATA1256903590=1599552095-1584151635-https%253A%252F%252Fwww.baidu.com%252F%7C1584704759; _cnzz_CV1256903590=is-logon%7Clogged-in%7C1584705067566%26urlname%7Cxpmvxxfddh%7C1584705067566; Hm_lpvt_d4a0e7c3cd16eb58a65472f40e7ee543=1584705067',

'Referer': 'https://huaban.com/discovery/i ... 27%3B,

'User-Agent': 'Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/69.0.3497.100 Safari/537.36',

'X-Request': 'JSON',

'X-Requested-With': 'XMLHttpRequest',

}

url="https://huaban.com/discovery/i ... ot%3B % id

html=requests.get(url,headers=headers,timeout=8).content.decode('utf-8')

time.sleep(1)

if html:

req=json.loads(html)

print(req)

boards=req['boards']

print(len(boards))

for board in boards:

print(board['title'])

sa = Save(board['title'])

sa.sav2()

#print(board['seq'])

next_id=boards[-1]['seq']

get_board(next_id)

if __name__ == '__main__':

id="1584416341304281760"

while True:

get_board(id)

使用while循环和自循环

最后保存到数据库

源代码

import pymysql

class Save(object):

def __init__(self,key):

self.host="localhost"

self.user="root"

self.password="123456"

self.db="xiaoshuo"

self.port=3306

self.connect = pymysql.connect(

host=self.host,

user=self.user,

password=self.password,

db=self.db,

port=self.port,

)

self.cursor = self.connect.cursor() # 设置游标

self.key=key

def insert(self):

for keyword in self.key:

try:

sql="INSERT INTO huaban(keyword)VALUES(%s)"

val = (keyword[0])

self.cursor.execute(sql, val)

self.connect.commit()

print(f'>>> 插入 {keyword[0]} 数据成功!')

except Exception as e:

print(e)

print(f'>>> 插入 {keyword[0]} 数据失败!')

def insert2(self):

keyword=self.key

try:

sql="INSERT INTO huaban2(keyword)VALUES(%s)"

val = keyword

self.cursor.execute(sql, val)

self.connect.commit()

print(f'>>> 插入 {keyword} 数据成功!')

except Exception as e:

print(e)

print(f'>>> 插入 {keyword} 数据失败!')

def cs(self):

# 关闭数据库

self.cursor.close()

self.connect.close()

def sav(self):

self.insert()

self.cs()

def sav2(self):

self.insert2()

self.cs()

关键词文章采集源码(对于爬取翻页的流程基本如下(有些)翻页流程)

采集交流 • 优采云 发表了文章 • 0 个评论 • 143 次浏览 • 2021-09-02 17:24

给出完整代码:(需要的请自行下载,有问题请留言)

pudn下载连接:

有时间我会写一篇百度图片和谷歌图片的python爬虫博客,我会带头。

Google 图片抓取工具连接:

百度图片爬虫连接:

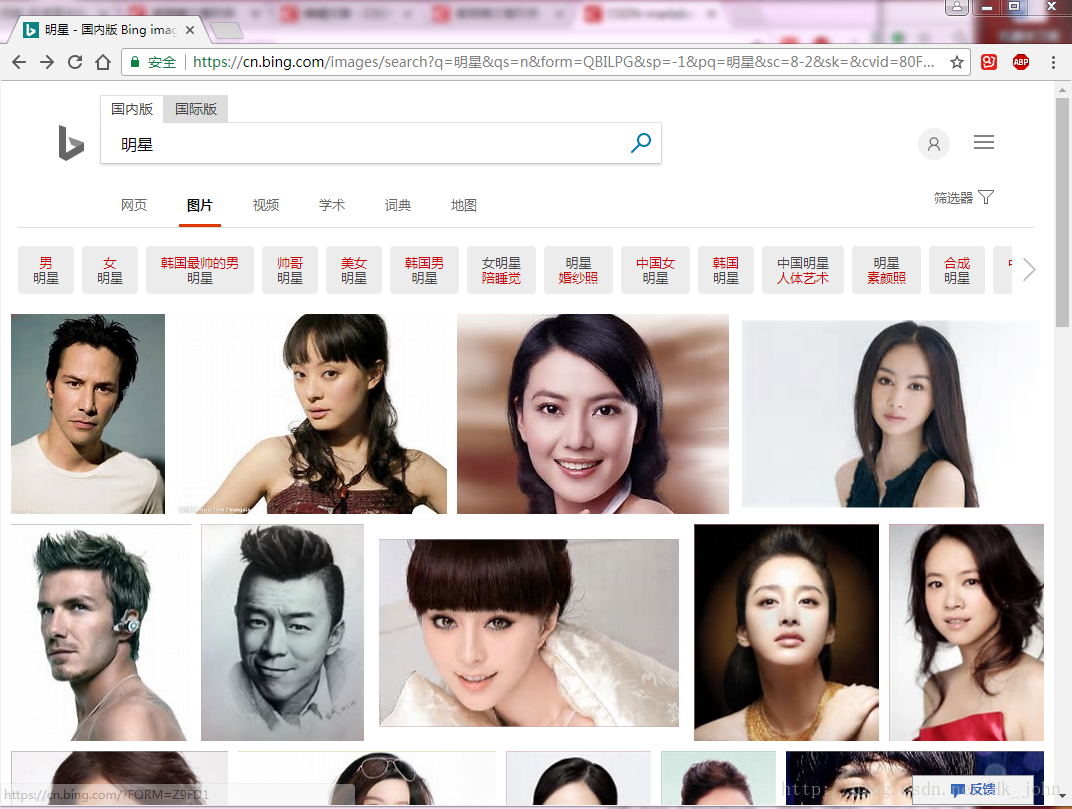

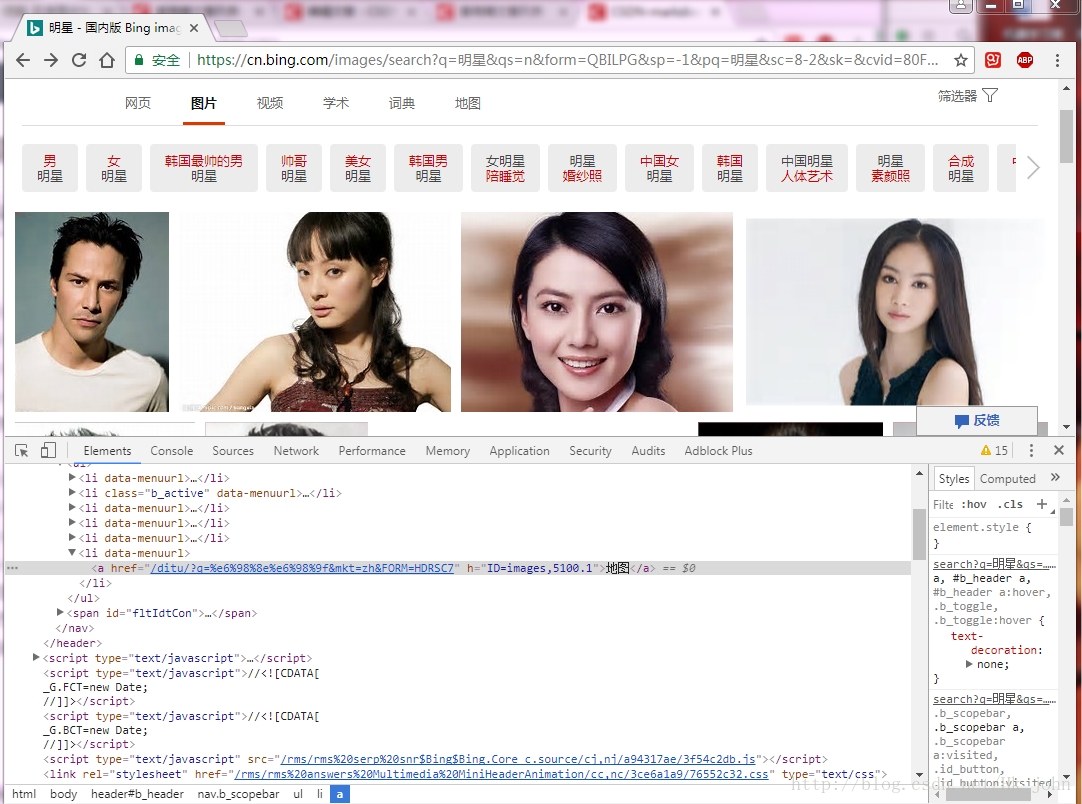

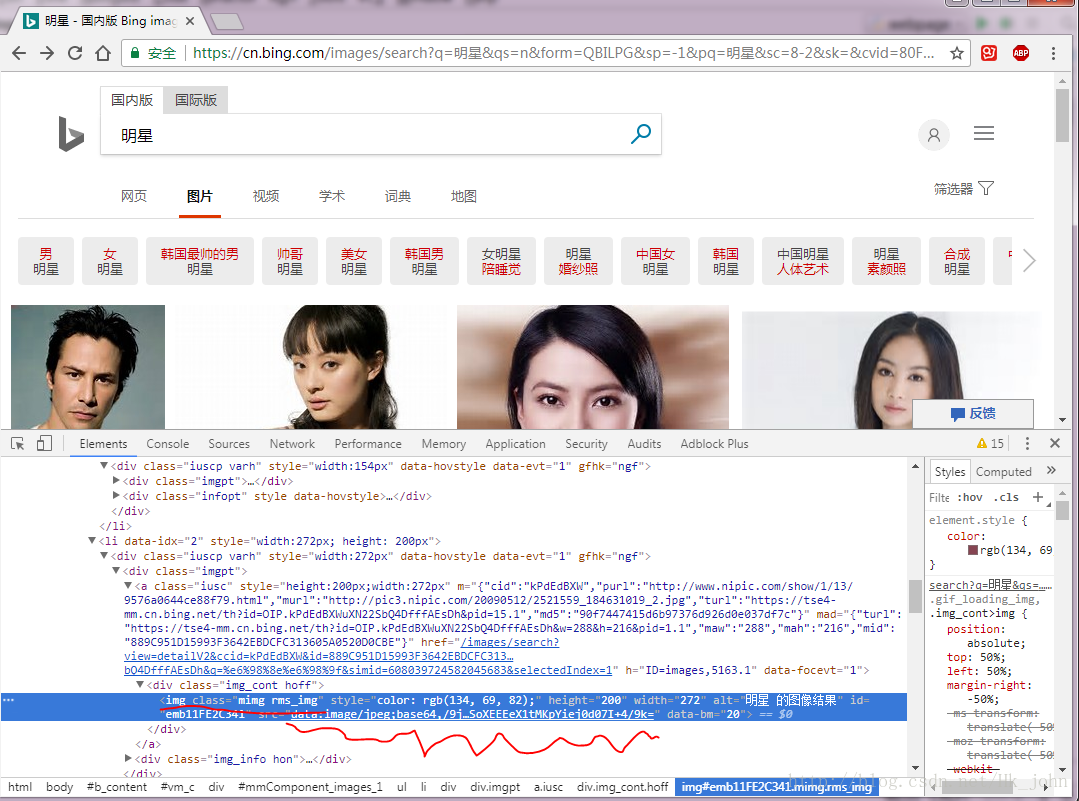

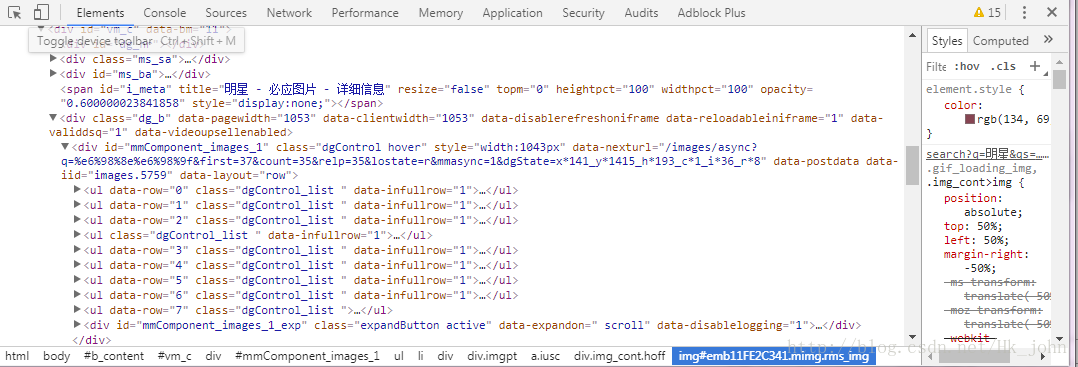

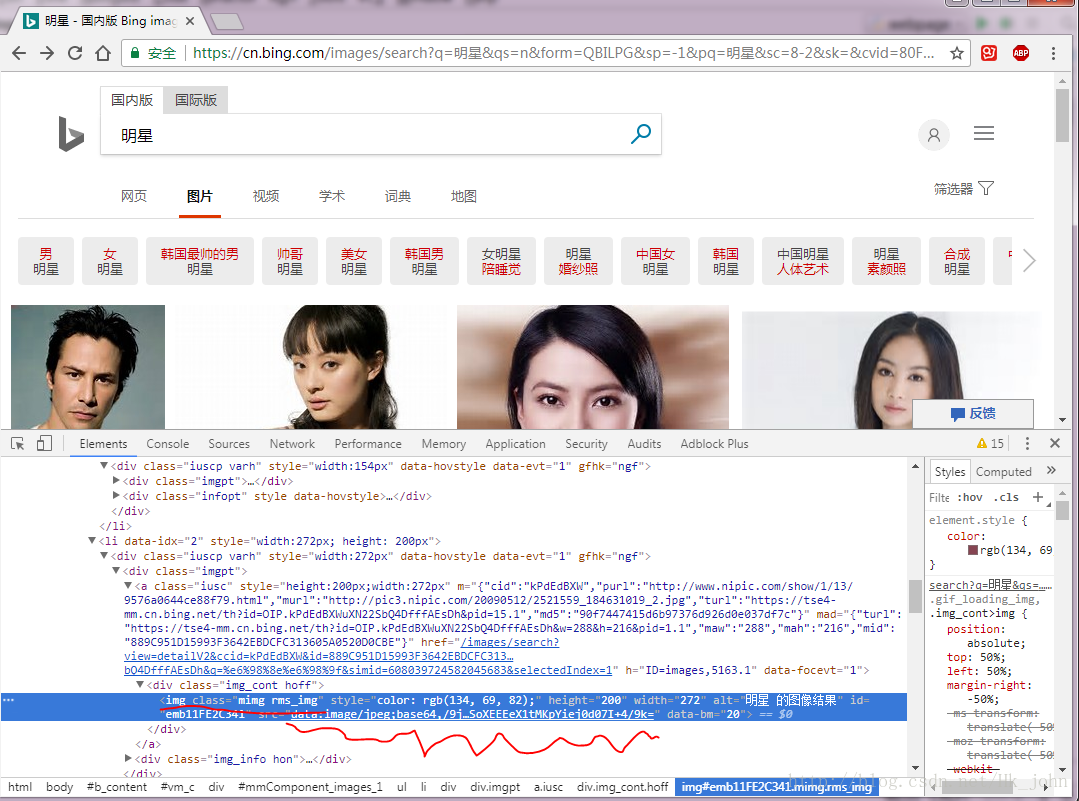

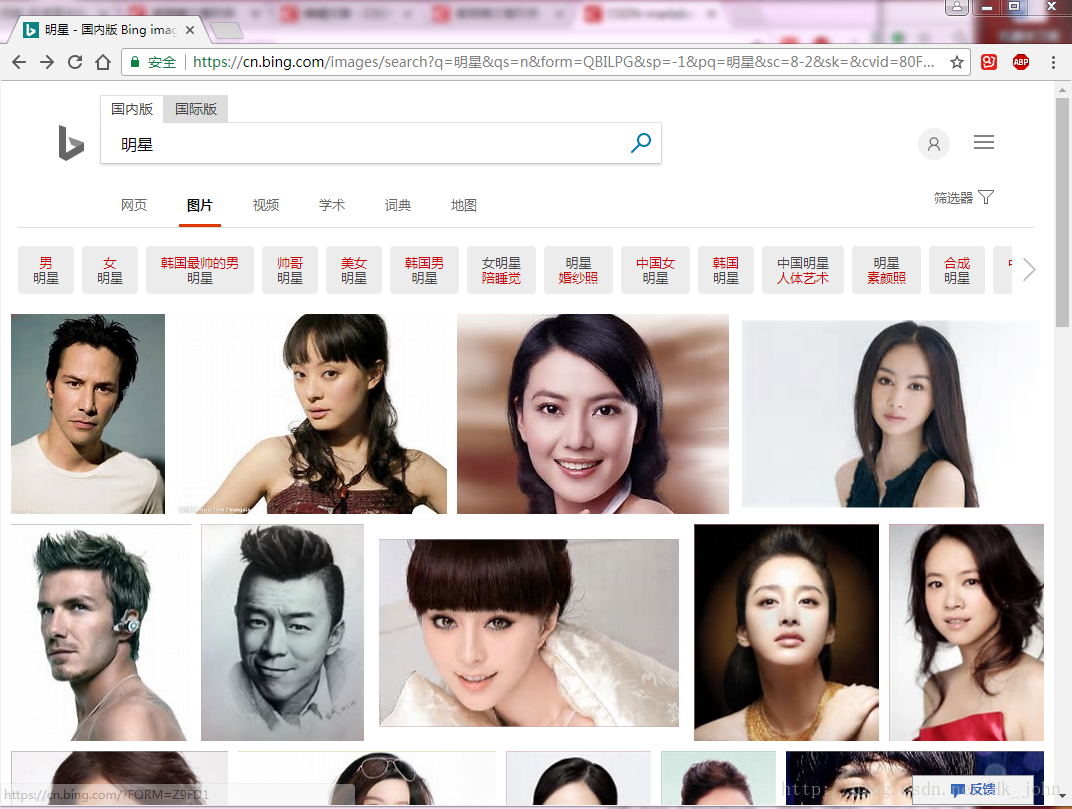

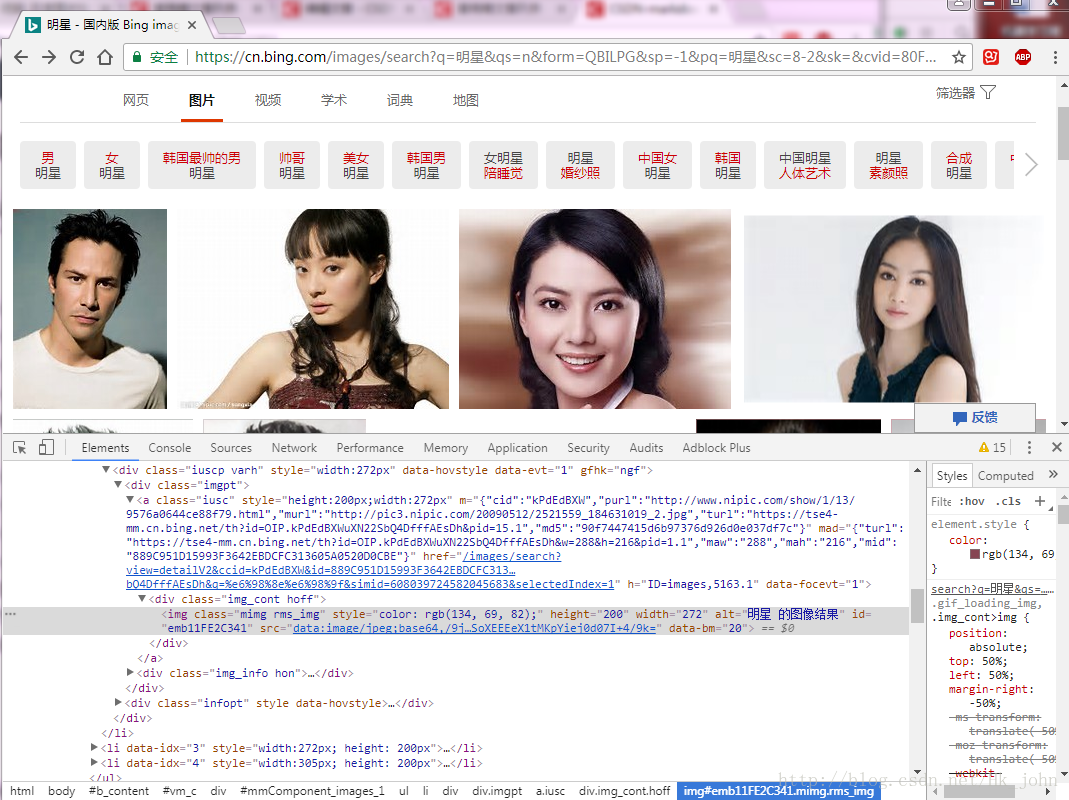

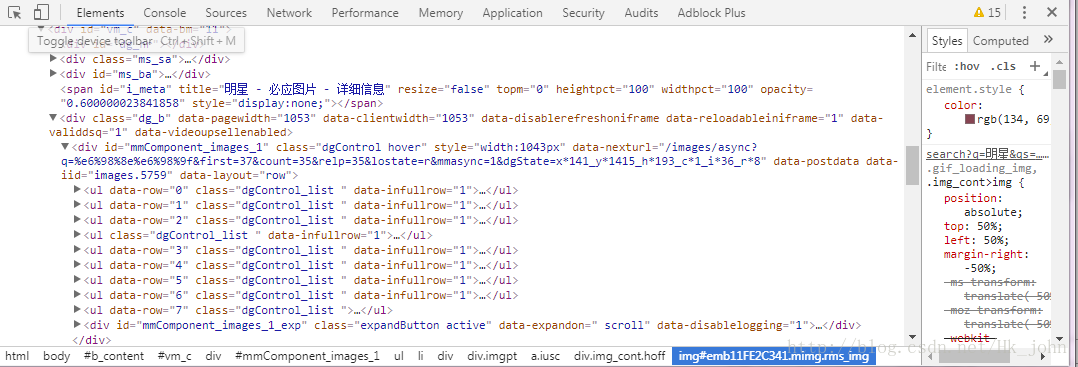

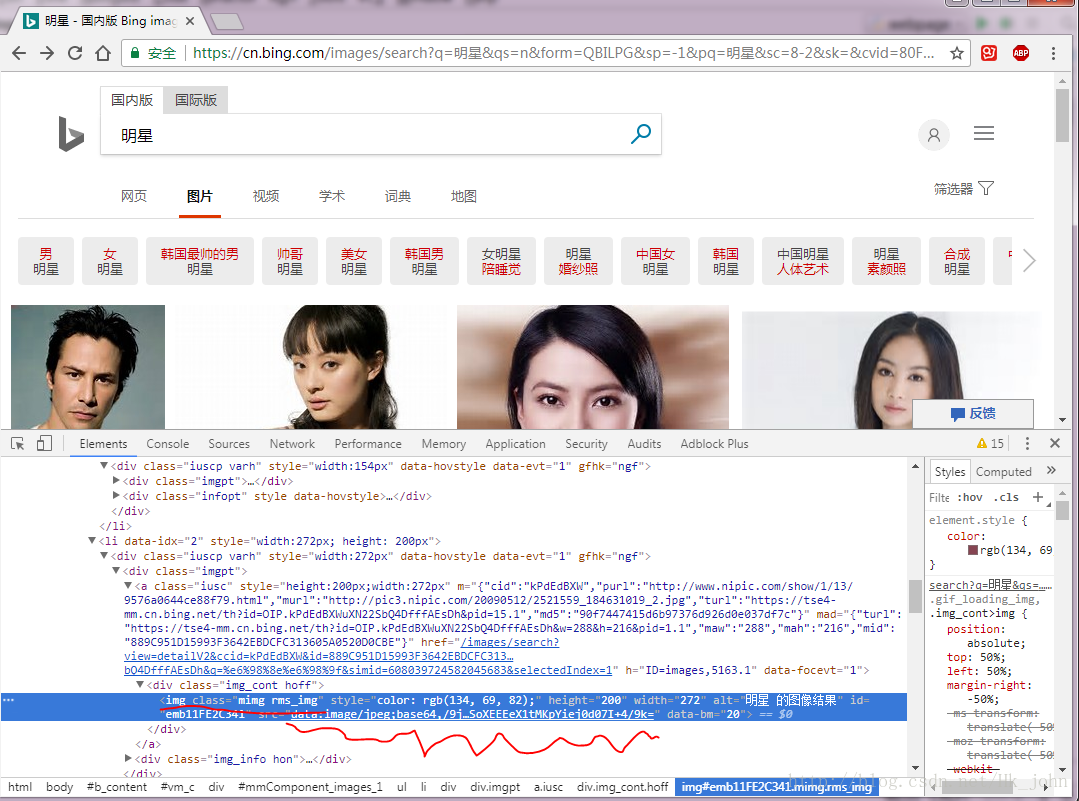

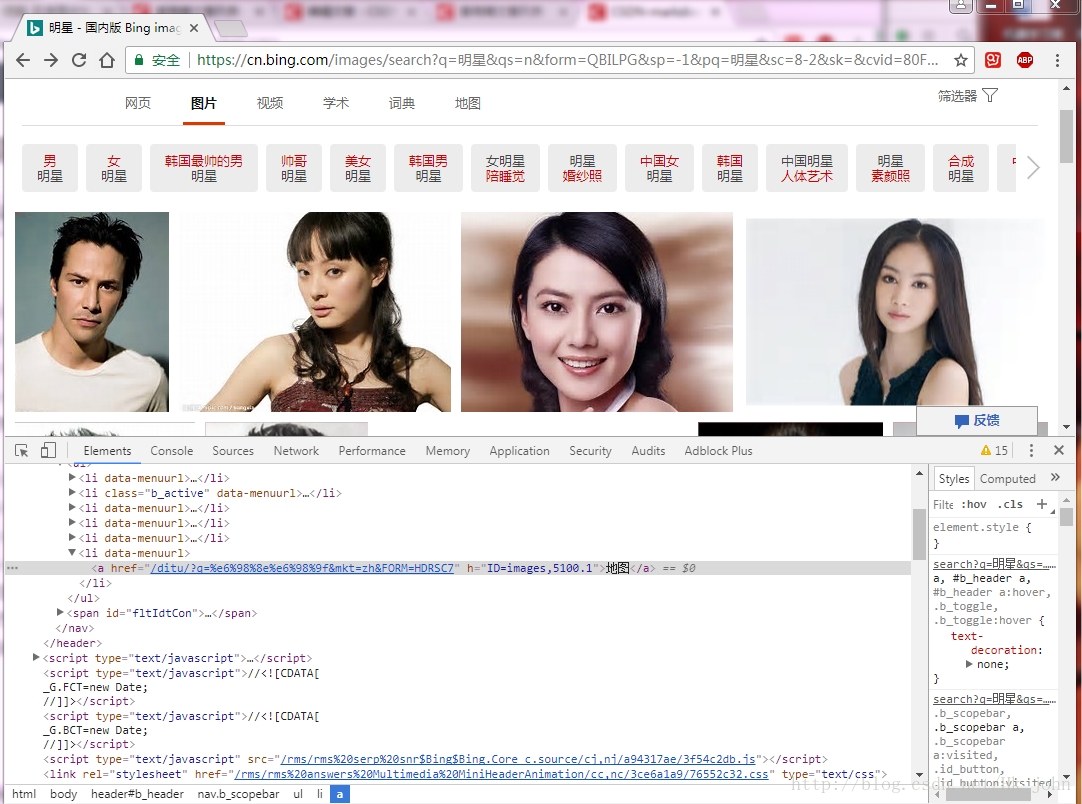

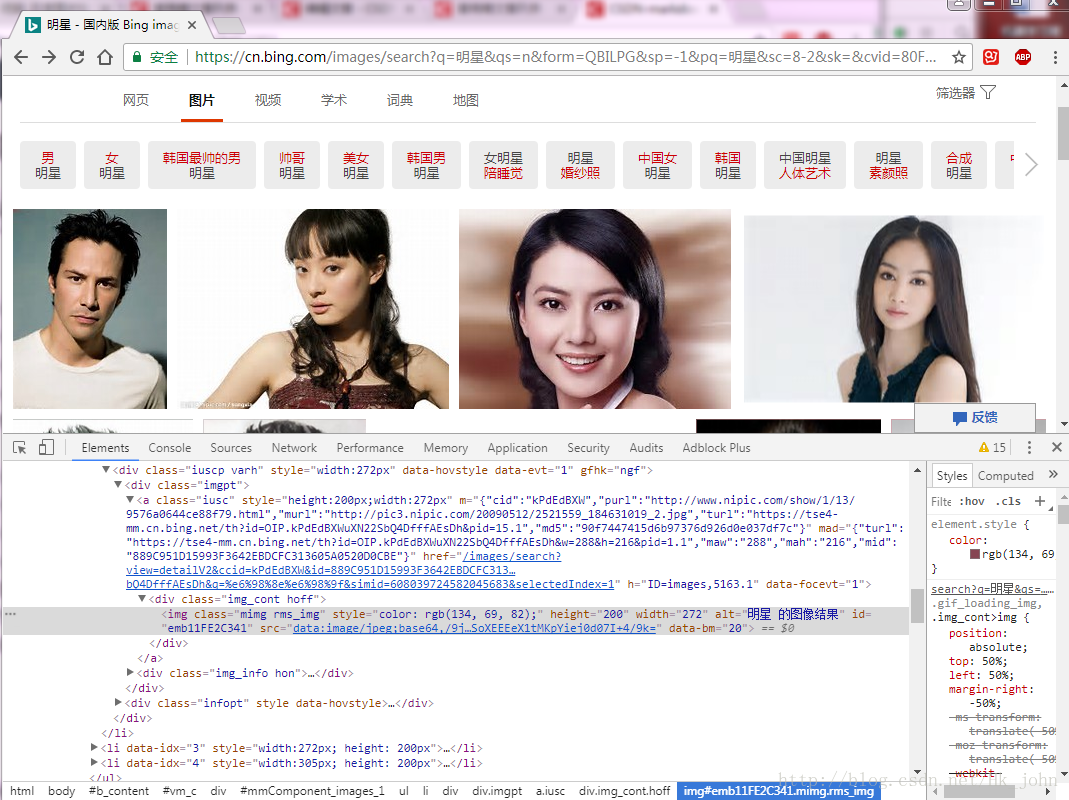

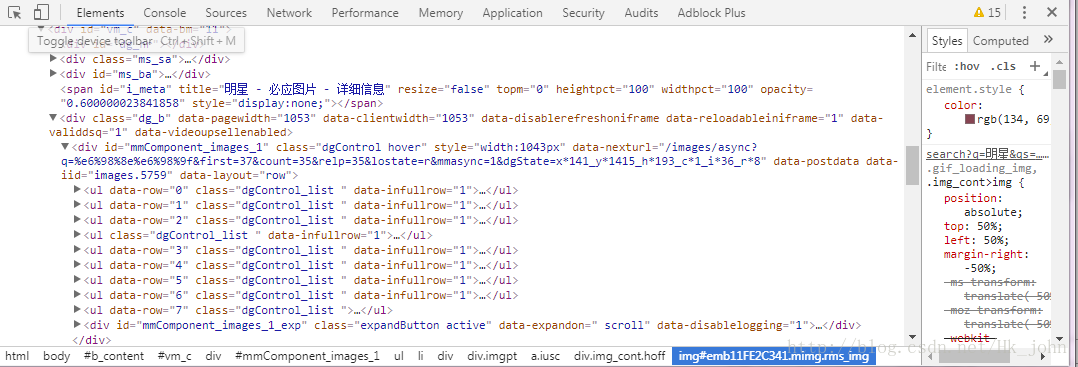

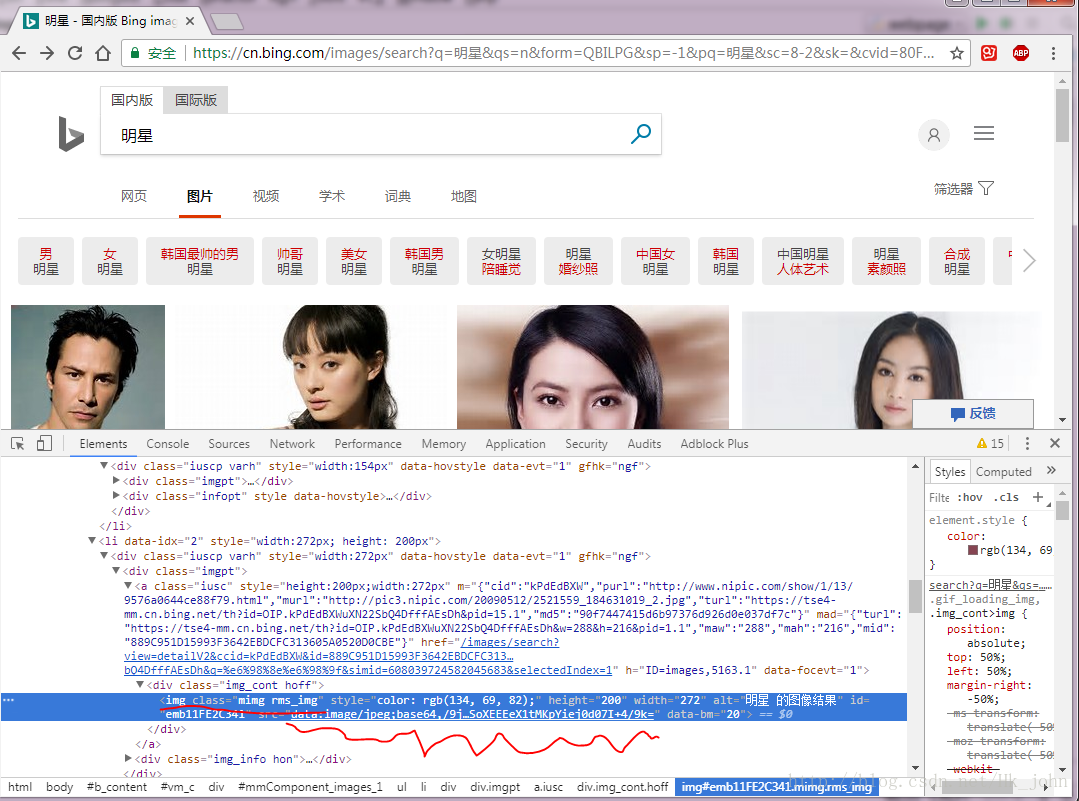

在此期间我正在实习。我正在做一些主要的网站 图片抓取工作。基本就告一段落了。现在搜索百度图片、谷歌图片、必应图片三张网站。抓取并下载结果。

首先通过爬取过程中遇到的问题,总结如下:

1、每次加载的图片数量每个网站都是可变的,每翻一页都会刷新。对于数据量大的爬虫,几乎都需要用到翻页功能。有以下两种方式:

1)通过网站上的网址刷新,如必应图片:

url = 'http://cn.bing.com/images/async?q={0}&first={1}&count=35&relp=35&lostate=r

&mmasync=1&dgState=x*175_y*848_h*199_c*1_i*106_r*0'

2) 使用 selenium 模拟鼠标操作来翻页,在谷歌图片抓取时会解释。

2、 每个网站 应用程序都有不同的图片加载技术。对于静态加载的网站,抓取图片非常容易,因为每个图片的url都直接显示在网页的源代码中。找到每个图片对应的url,可以使用urlretrieve()下载。但是动态加载的网站比较复杂,需要具体问题具体分析。例如,Google Pictures 每次加载 35 张图片(只能获取 35 张图片的 URL)。当滚动一次时,网页不会刷新,而是再次加载一批图片,并与之前加载的图片一起显示在网页的源代码中。对于动态加载的网站,我推荐使用selenium库来爬取。

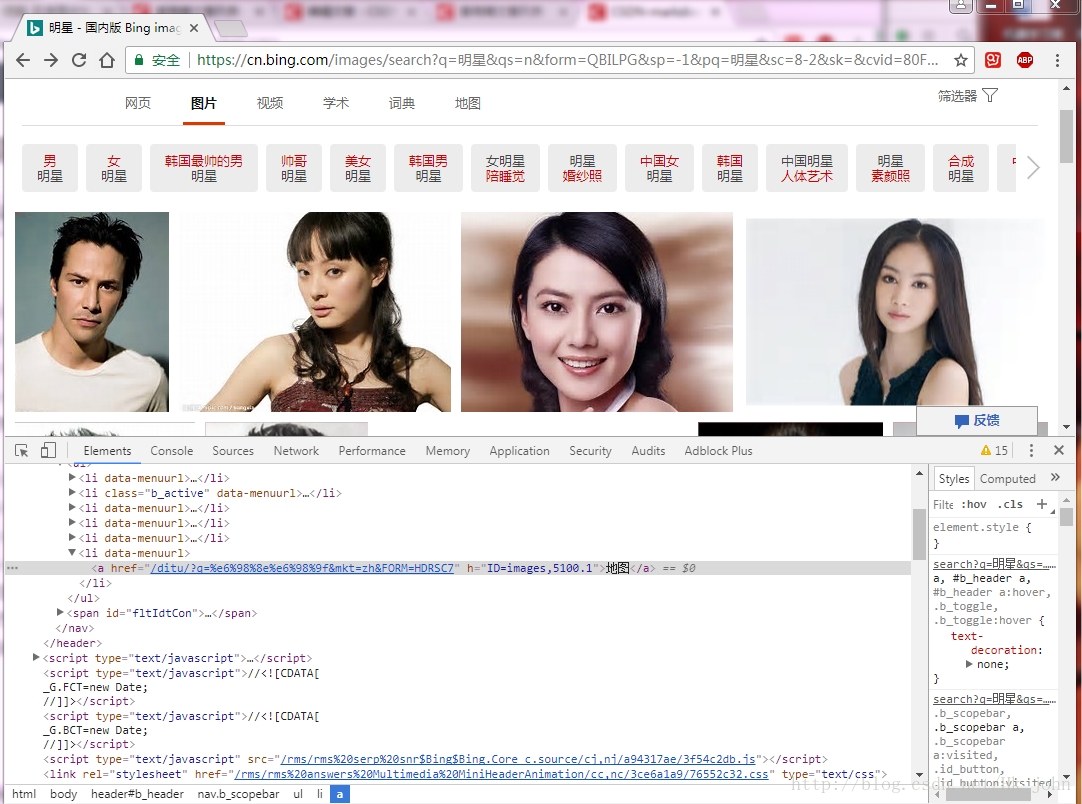

抓取图片的过程基本如下(对于网站可以通过URL翻页或者不需要翻页):

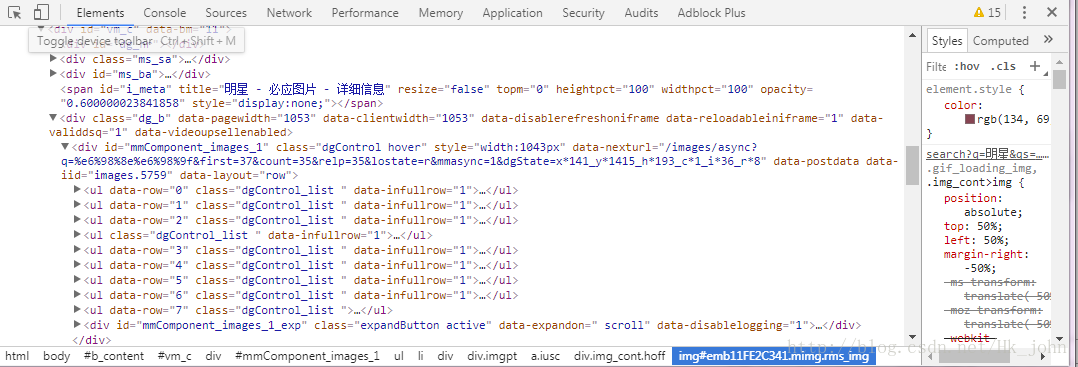

1. 找到你需要爬取图片的网站。 (以必应为例)

2. 使用google element check(其他没用过,不再介绍)查看网页源码。

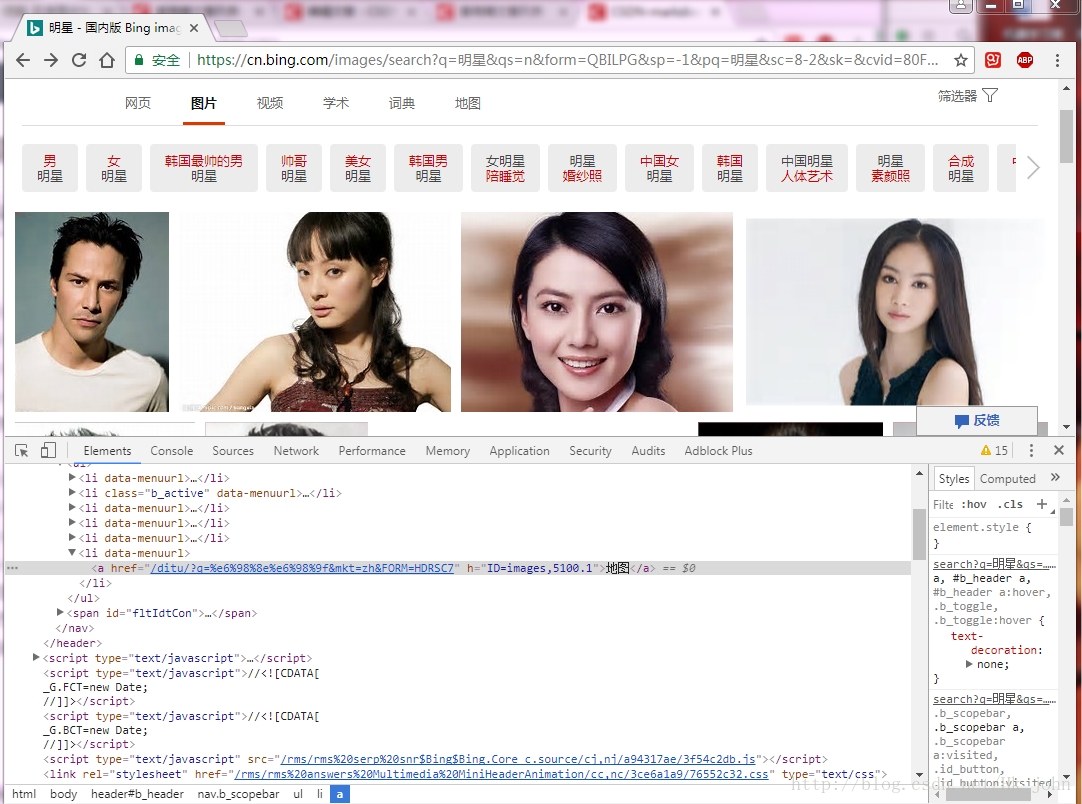

3. 使用左上角的元素检查找到图片对应的代码。

4.通过观察找到翻页的规律(有的网站动态加载是完全不可见的,不推荐这种方法)

从图中可以看到标签div,class='dgControl hover'中data-nexturl的内容会随着我们滚动页面和先翻页而不断变化,q=binary code是我们的关键词。添加前缀后,我们就得到了我们要使用的url。

5.我们把网页的源码放到BeautifulSoup中,代码如下:

url = 'http://cn.bing.com/images/async?q={0}&first={1}&count=35&relp=35&lostate=r&mmasync=1&dgState=x*175_y*848_h*199_c*1_i*106_r*0'

agent = {'User-Agent': "Mozilla/5.0 (X11; Linux x86_64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/31.0.165063 Safari/537.36 AppEngine-Google."}

page1 = urllib.request.Request(url.format(InputData, i*35+1), headers=agent)

page = urllib.request.urlopen(page1)

soup = BeautifulSoup(page.read(), 'html.parser')

我们得到的汤是一个类‘bs4.BeautifulSoup’对象,可以直接操作,具体内容可以自行搜索。

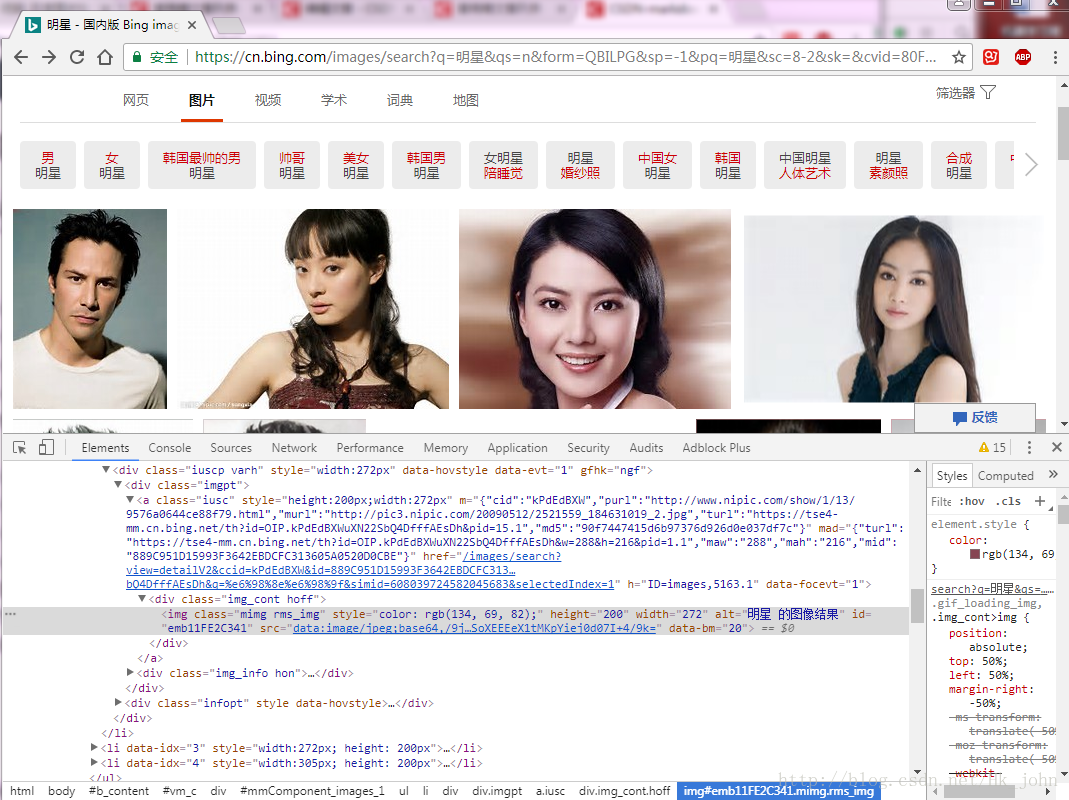

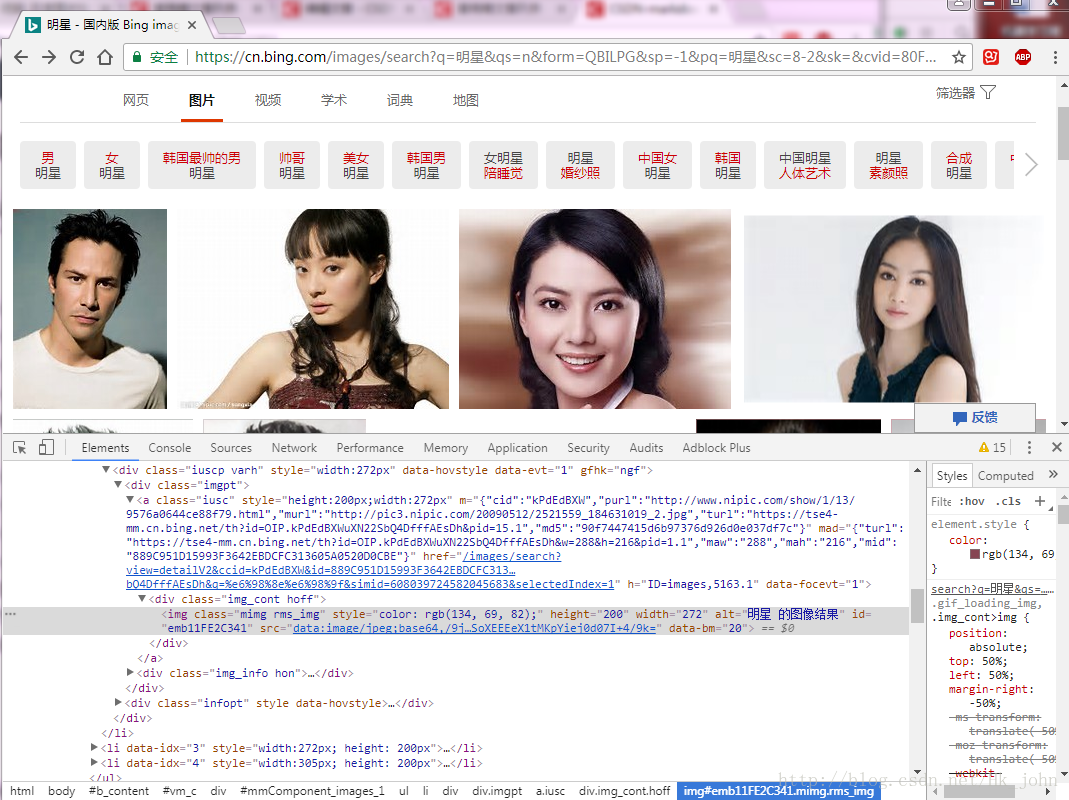

首先选择我们需要的url所在的类,如下图:

波浪线是我们需要的网址。

我们从下面的代码中得到我们需要的url:

if not os.path.exists("./" + word):#创建文件夹

os.mkdir('./' + word)

for StepOne in soup.select('.mimg'):

link=StepOne.attrs['src']#将得到的转化为字典形式并取src对应的value。

count = len(os.listdir('./' + word)) + 1

SaveImage(link,word,count)#调用函数保存得到的图片。

最后调用urlretrieve()函数下载我们得到的图片url,代码如下:

try:

time.sleep(0.2)

urllib.request.urlretrieve(link,'./'+InputData+'/'+str(count)+'.jpg')

except urllib.error.HTTPError as urllib_err:

print(urllib_err)

except Exception as err:

time.sleep(1)

print(err)

print("产生未知错误,放弃保存")

else:

print("图+1,已有" + str(count) + "张图")

这里需要强调的是,除了像之前打开的URL和当前下载的图片这样的错误检测之外,需要使用try,否则程序出现错误时很容易崩溃,极大地浪费了数据时间采集. 查看全部

关键词文章采集源码(对于爬取翻页的流程基本如下(有些)翻页流程)

给出完整代码:(需要的请自行下载,有问题请留言)

pudn下载连接:

有时间我会写一篇百度图片和谷歌图片的python爬虫博客,我会带头。

Google 图片抓取工具连接:

百度图片爬虫连接:

在此期间我正在实习。我正在做一些主要的网站 图片抓取工作。基本就告一段落了。现在搜索百度图片、谷歌图片、必应图片三张网站。抓取并下载结果。

首先通过爬取过程中遇到的问题,总结如下:

1、每次加载的图片数量每个网站都是可变的,每翻一页都会刷新。对于数据量大的爬虫,几乎都需要用到翻页功能。有以下两种方式:

1)通过网站上的网址刷新,如必应图片:

url = 'http://cn.bing.com/images/async?q={0}&first={1}&count=35&relp=35&lostate=r

&mmasync=1&dgState=x*175_y*848_h*199_c*1_i*106_r*0'

2) 使用 selenium 模拟鼠标操作来翻页,在谷歌图片抓取时会解释。

2、 每个网站 应用程序都有不同的图片加载技术。对于静态加载的网站,抓取图片非常容易,因为每个图片的url都直接显示在网页的源代码中。找到每个图片对应的url,可以使用urlretrieve()下载。但是动态加载的网站比较复杂,需要具体问题具体分析。例如,Google Pictures 每次加载 35 张图片(只能获取 35 张图片的 URL)。当滚动一次时,网页不会刷新,而是再次加载一批图片,并与之前加载的图片一起显示在网页的源代码中。对于动态加载的网站,我推荐使用selenium库来爬取。

抓取图片的过程基本如下(对于网站可以通过URL翻页或者不需要翻页):

1. 找到你需要爬取图片的网站。 (以必应为例)

2. 使用google element check(其他没用过,不再介绍)查看网页源码。

3. 使用左上角的元素检查找到图片对应的代码。

4.通过观察找到翻页的规律(有的网站动态加载是完全不可见的,不推荐这种方法)

从图中可以看到标签div,class='dgControl hover'中data-nexturl的内容会随着我们滚动页面和先翻页而不断变化,q=binary code是我们的关键词。添加前缀后,我们就得到了我们要使用的url。

5.我们把网页的源码放到BeautifulSoup中,代码如下:

url = 'http://cn.bing.com/images/async?q={0}&first={1}&count=35&relp=35&lostate=r&mmasync=1&dgState=x*175_y*848_h*199_c*1_i*106_r*0'

agent = {'User-Agent': "Mozilla/5.0 (X11; Linux x86_64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/31.0.165063 Safari/537.36 AppEngine-Google."}

page1 = urllib.request.Request(url.format(InputData, i*35+1), headers=agent)

page = urllib.request.urlopen(page1)

soup = BeautifulSoup(page.read(), 'html.parser')

我们得到的汤是一个类‘bs4.BeautifulSoup’对象,可以直接操作,具体内容可以自行搜索。

首先选择我们需要的url所在的类,如下图:

波浪线是我们需要的网址。

我们从下面的代码中得到我们需要的url:

if not os.path.exists("./" + word):#创建文件夹

os.mkdir('./' + word)

for StepOne in soup.select('.mimg'):

link=StepOne.attrs['src']#将得到的转化为字典形式并取src对应的value。

count = len(os.listdir('./' + word)) + 1

SaveImage(link,word,count)#调用函数保存得到的图片。

最后调用urlretrieve()函数下载我们得到的图片url,代码如下:

try:

time.sleep(0.2)

urllib.request.urlretrieve(link,'./'+InputData+'/'+str(count)+'.jpg')

except urllib.error.HTTPError as urllib_err:

print(urllib_err)

except Exception as err:

time.sleep(1)

print(err)

print("产生未知错误,放弃保存")

else:

print("图+1,已有" + str(count) + "张图")

这里需要强调的是,除了像之前打开的URL和当前下载的图片这样的错误检测之外,需要使用try,否则程序出现错误时很容易崩溃,极大地浪费了数据时间采集.

关键词文章采集源码(关键词文章采集源码+评论信息采集系统核心代码实力)

采集交流 • 优采云 发表了文章 • 0 个评论 • 155 次浏览 • 2021-09-02 09:12

关键词文章采集源码+评论信息采集采集系统评论信息采集系统核心代码代码实力源码获取:提取码:7ny0源码免费提供与分享,评论信息采集系统不收取任何费用,源码获取方式见文章末尾了解评论信息采集系统后,下面我们来看看评论信息采集系统源码获取及评论信息的采集操作方法1.新建评论信息采集网站1.评论内容在后台编辑,评论内容左键点击获取即可,引号里输入评论话题内容即可;2.评论信息准备好后,便可开始评论了,我们可以新建列表、新建记录,新建列表按钮:新建;新建记录按钮:新建;评论信息搜索引擎:本软件已有,选择快速测试2.评论内容搜索本网站内容丰富,当评论内容在后台编辑好后,我们可以用一些技术手段把评论内容从后台里上传,上传评论内容到评论信息采集系统,在采集过程中,我们可以用指定地区或者是指定邮箱来筛选感兴趣的评论内容:在评论页面,选择上传评论信息到记录或者是上传信息到采集列表,如下图所示:3.抓取评论信息信息采集系统的评论信息采集,可以按照评论内容的开头、中间、结尾来依次抓取信息,但是从评论评论信息数量上来看,可以将评论内容分为3种,分别对应评论时间、评论地域、评论内容。

评论数量少的评论采集效率会比较低,但是需要相对较多内容评论的评论数量较多的评论,我们不仅需要采集评论内容,还需要采集评论地域和评论内容等,这样才能符合我们采集的需求。采集评论信息使用技巧1.抓取评论内容的方法我们可以设置某个评论内容的浏览信息页面,然后在这个页面对应内容处采集,这样可以进行大数据量的评论抓取。

也可以在评论内容的开头、中间、结尾处依次抓取。2.使用评论信息采集系统的原因评论系统可以实现平台选择、数据自动抓取、评论搜索定位等功能,可以帮助我们更好的发现新的评论信息。另外如果评论信息采集系统未设置好相关的邮箱和账号的话,可以抓取评论信息的时候使用其他软件收集然后在系统里进行存储处理,这样就会变的非常的方便。

3.评论信息采集系统的使用技巧下面详细介绍了评论信息采集系统的使用技巧,根据文章内容进行操作即可。1.手机发短信订阅评论信息2.im聊天说评论3.邀请其他人进行评论采集4.通过友情链接收集评论内容5.评论内容规则采集设置和评论内容规则存储6.评论的广告联盟收集评论内容7.报名参加评论协会8.评论内容入库9.总结等。

9.评论信息采集系统源码获取方式1.手机发短信订阅评论信息软件可以根据评论内容自动的触发订阅邮箱或者是自动的接收评论,根据文章内容,搜索“评。 查看全部

关键词文章采集源码(关键词文章采集源码+评论信息采集系统核心代码实力)

关键词文章采集源码+评论信息采集采集系统评论信息采集系统核心代码代码实力源码获取:提取码:7ny0源码免费提供与分享,评论信息采集系统不收取任何费用,源码获取方式见文章末尾了解评论信息采集系统后,下面我们来看看评论信息采集系统源码获取及评论信息的采集操作方法1.新建评论信息采集网站1.评论内容在后台编辑,评论内容左键点击获取即可,引号里输入评论话题内容即可;2.评论信息准备好后,便可开始评论了,我们可以新建列表、新建记录,新建列表按钮:新建;新建记录按钮:新建;评论信息搜索引擎:本软件已有,选择快速测试2.评论内容搜索本网站内容丰富,当评论内容在后台编辑好后,我们可以用一些技术手段把评论内容从后台里上传,上传评论内容到评论信息采集系统,在采集过程中,我们可以用指定地区或者是指定邮箱来筛选感兴趣的评论内容:在评论页面,选择上传评论信息到记录或者是上传信息到采集列表,如下图所示:3.抓取评论信息信息采集系统的评论信息采集,可以按照评论内容的开头、中间、结尾来依次抓取信息,但是从评论评论信息数量上来看,可以将评论内容分为3种,分别对应评论时间、评论地域、评论内容。

评论数量少的评论采集效率会比较低,但是需要相对较多内容评论的评论数量较多的评论,我们不仅需要采集评论内容,还需要采集评论地域和评论内容等,这样才能符合我们采集的需求。采集评论信息使用技巧1.抓取评论内容的方法我们可以设置某个评论内容的浏览信息页面,然后在这个页面对应内容处采集,这样可以进行大数据量的评论抓取。

也可以在评论内容的开头、中间、结尾处依次抓取。2.使用评论信息采集系统的原因评论系统可以实现平台选择、数据自动抓取、评论搜索定位等功能,可以帮助我们更好的发现新的评论信息。另外如果评论信息采集系统未设置好相关的邮箱和账号的话,可以抓取评论信息的时候使用其他软件收集然后在系统里进行存储处理,这样就会变的非常的方便。

3.评论信息采集系统的使用技巧下面详细介绍了评论信息采集系统的使用技巧,根据文章内容进行操作即可。1.手机发短信订阅评论信息2.im聊天说评论3.邀请其他人进行评论采集4.通过友情链接收集评论内容5.评论内容规则采集设置和评论内容规则存储6.评论的广告联盟收集评论内容7.报名参加评论协会8.评论内容入库9.总结等。

9.评论信息采集系统源码获取方式1.手机发短信订阅评论信息软件可以根据评论内容自动的触发订阅邮箱或者是自动的接收评论,根据文章内容,搜索“评。

关键词文章采集源码(完美运行于的WordPress各个版本,请放心使用!)

采集交流 • 优采云 发表了文章 • 0 个评论 • 160 次浏览 • 2021-09-02 02:09

目前所有版本的 WordPress 都运行良好,请放心使用。 WP-AutoPost-Pro是一款优秀的WordPress文章采集器,是您操作站群,让网站自动更新内容的强大工具!如果您是新手,请查看采集tutorial:

官网直接链接:此版本与官方功能无区别;

采集Plugin 适用对象

1、刚建的wordpress网站内容比较少,希望尽快有更丰富的内容;

2、热门内容自动采集自动发布;

3、timing采集,手动采集发布或保存到草稿;

4、css 样式规则可以更精确地满足采集 的需求。

5、伪原创采集带有翻译和代理IP,保存cookie记录;

6、可采集Content 到自定义列

WP-AutoBlog是新开发的插件(原WP-AutoPost不再更新维护),全面支持PHP7.3更快更稳定

全新架构设计,采集设置更全面灵活;支持多级文章List,多级文章内容采集

新增支持谷歌神经网络翻译、有道神经网络翻译,轻松获取优质原创文章

全面支持市面上所有主流对象存储服务,七牛云、阿里云OSS等

采集微信公号、头条号等自媒体内容,因为百度没有收录公号、头条文章等,轻松获取优质“原创”文章,加百度收录量及网站权重

采集any网站内容,采集信息一目了然

通过简单的设置,采集可以来自任何网站内容,并且可以设置多个采集任务同时运行。任务可以设置为自动或手动运行。主任务列表显示每个采集任务的状态:上次检测采集时间,预计下次检测采集时间,最新采集文章,文章编号更新采集等信息,方便查看和管理。

文章 管理功能方便查询、查找、删除。 采集文章,改进后的算法从根本上杜绝了采集同文章的重复,日志功能记录采集过程中的异常并抓取错误,方便查看设置错误以修复它。

任务开启后会自动更新采集,无需人工干预

任务开启后,查看是否有新的文章updateable,查看文章是否重复,导入更新文章。所有这些操作都是自动完成的,无需人工干预。

触发采集update有两种方式,一种是在页面添加代码,通过用户访问触发采集update(后端异步,不影响用户体验,不影响网站效率),另一个可以使用Cron调度任务定时触发采集update任务

目标采集,支持通配符匹配,或者CSS选择器精确采集any内容,支持采集multi-level文章list,支持采集body分页内容,支持采集multi-级别正文内容

定位采集 只需提供文章list URL 即可智能采集 来自任何网站 或列内容。

不仅支持对采集网页内容的“通配符匹配”,还完美支持各种CSS选择器。只需填写一个简单的 CSS 选择器,如 #title h1,即可准确地采集 网页上的任何内容。 (如何设置 CSS 选择器)

支持设置关键词,如果标题收录关键词,则只允许采集(或过滤掉采集不允许)。

支持设置多条匹配规则采集网页不同内容,甚至支持采集任意内容添加到“WordPress自定义栏目”中,方便扩展。

基础设置齐全,完美支持Wordpress的各种功能。可自动设置分类、标签、摘要、特色图片、自定义栏目等;还可以发布采集target网站的分类、标签等信息,可以自动生成并添加对应的分类目录、标签等信息

每个采集任务可以选择发布到的类别、发布作者、发布状态、查看和更新时间间隔、采集target网站字符集、选择是否下载图片或附件。

支持自定义文章类型、自定义文章类别、文章表单。

完美支持Wordpress各种功能,自动添加标签,自动生成摘要,自动设置特色图片,支持自定义栏目等

采集微信公号、头条号等自媒体内容,因为百度没有收录公号、头条文章等,轻松获取优质“原创” 文章,加百度收录量和网站权重

支持采集微信公号(订阅号)文章,无需复杂配置,只需填写“公众号”和“微信ID”即可启动采集。

支持采集今日头条文章无需复杂配置

支持谷歌神经网络翻译、有道神经网络翻译、百度翻译,将文章翻译成其他语言,轻松搞定原创文章

支持谷歌神经网络翻译,翻译质量得到显着提升,接近人工翻译效果。 文章title和内容翻译成其他语言,支持多语言互译。 原创文章 很容易获得。使用谷歌翻译API无需翻墙,翻墙获取API相关设置信息即可正常使用,使用时无需翻墙稍后调用 API 翻译

支持有道神经网络翻译,接近人工翻译效果,有道翻译更懂中文,采集中文文章translate成中文文章,轻松搞定原创文章。

同时支持百度翻译。百度翻译月翻译字200万以内,享受免费服务

支持多种伪原创中英文方法

支持使用翻译引擎获取伪原创文章,不仅替换同义词,还重述语义。唯一性和伪原创更好,支持多种语言。同时集成了国外最好的伪原创工具WordAi等,使得一个英文站可以获得更具可读性和独特性的伪原创文章。

远程图片和其他任何格式的附件均可下载到本地服务器,并自动给图片添加水印

支持远程图片下载到本地服务器,可以选择自动添加文字水印或图片水印。任何其他格式的附件和文档也可以轻松下载到本地服务器。

支持市面上所有主流的对象存储服务,包括七牛云、阿里云OSS、腾讯云COS、百度云BOS、优派云、亚马逊AWS S3、Google云存储、文章中图片及附件自动上传到云对象存储服务,节省带宽和空间,提高网站访问速度

七牛云存储,每月10GB免费存储空间,10GB免费带宽流量

只需简单配置相关信息,即可自动上传,并可通过Wordpress后台直接查看或管理上传至云对象存储的图片和文件。

支持SEO优化、内容过滤、HTML标签过滤、关键词替换、自动添加链接、添加自定义内容、自定义采集帖子样式、自定义模板等常用功能

自动删除采集内容中的HTML注释,可以设置删除标签中的id、class、style属性内容,消除采集的痕迹;自动给图片添加alt属性,过滤链接,替换关键词,自动添加自定义链接,这些都有利于SEO。

支持内容过滤,过滤不想发布的采集内容(如广告代码、文章source、版权等信息),甚至可以在文章任意位置添加自定义内容进行增强文章唯一性;也可以设置采集后添加自定义样式功能

还支持HTML标签过滤功能,可以过滤掉采集文章中的超链接、script和style标签下不需要的代码。

本资源下载价格为1金币,请先登录

☆下载协议☆下载前请阅读本协议。如果您已下载,本站将视为您已阅读并接受以下协议。

1. 下载内容不收录其技术服务。小白不建议下载。如果您需要在本站提供有偿技术服务,请联系我们。

2.本站所有资源均来自互联网,版权归原作者所有,请保留原版权信息。

3.本站分享仅供参考、学习和演示。不保证一切都能正常演示,也不能保证授权和破解。因此,不支持下载内容后的所有争议。请自行选择下载。

4.如果你抱着下载可以直接正常使用的心态,请跳过,建议不要下载。如需商业用途,请选择官方渠道购买正版!

资源下载

下载价格:1金币

VIP 折扣:免费

☆下载协议☆下载前请阅读本协议。如果您已下载,本站将视为您已阅读并接受以下协议。

1. 下载内容不收录其技术服务。小白不建议下载。如果您需要在本站提供有偿技术服务,请联系我们。

2.本站所有资源均来自互联网,版权归原作者所有,请保留原版权信息。

3.本站分享仅供参考、学习和演示。不保证一切都能正常演示,也不能保证授权和破解。因此,不支持下载内容后的所有争议。请自行选择下载。

4.如果你抱着下载可以直接正常使用的心态,请跳过,建议不要下载。如需商业用途,请选择官方渠道购买正版! 查看全部

关键词文章采集源码(完美运行于的WordPress各个版本,请放心使用!)

目前所有版本的 WordPress 都运行良好,请放心使用。 WP-AutoPost-Pro是一款优秀的WordPress文章采集器,是您操作站群,让网站自动更新内容的强大工具!如果您是新手,请查看采集tutorial:

官网直接链接:此版本与官方功能无区别;

采集Plugin 适用对象

1、刚建的wordpress网站内容比较少,希望尽快有更丰富的内容;

2、热门内容自动采集自动发布;

3、timing采集,手动采集发布或保存到草稿;

4、css 样式规则可以更精确地满足采集 的需求。

5、伪原创采集带有翻译和代理IP,保存cookie记录;

6、可采集Content 到自定义列

WP-AutoBlog是新开发的插件(原WP-AutoPost不再更新维护),全面支持PHP7.3更快更稳定

全新架构设计,采集设置更全面灵活;支持多级文章List,多级文章内容采集

新增支持谷歌神经网络翻译、有道神经网络翻译,轻松获取优质原创文章

全面支持市面上所有主流对象存储服务,七牛云、阿里云OSS等

采集微信公号、头条号等自媒体内容,因为百度没有收录公号、头条文章等,轻松获取优质“原创”文章,加百度收录量及网站权重

采集any网站内容,采集信息一目了然

通过简单的设置,采集可以来自任何网站内容,并且可以设置多个采集任务同时运行。任务可以设置为自动或手动运行。主任务列表显示每个采集任务的状态:上次检测采集时间,预计下次检测采集时间,最新采集文章,文章编号更新采集等信息,方便查看和管理。

文章 管理功能方便查询、查找、删除。 采集文章,改进后的算法从根本上杜绝了采集同文章的重复,日志功能记录采集过程中的异常并抓取错误,方便查看设置错误以修复它。

任务开启后会自动更新采集,无需人工干预

任务开启后,查看是否有新的文章updateable,查看文章是否重复,导入更新文章。所有这些操作都是自动完成的,无需人工干预。

触发采集update有两种方式,一种是在页面添加代码,通过用户访问触发采集update(后端异步,不影响用户体验,不影响网站效率),另一个可以使用Cron调度任务定时触发采集update任务

目标采集,支持通配符匹配,或者CSS选择器精确采集any内容,支持采集multi-level文章list,支持采集body分页内容,支持采集multi-级别正文内容

定位采集 只需提供文章list URL 即可智能采集 来自任何网站 或列内容。

不仅支持对采集网页内容的“通配符匹配”,还完美支持各种CSS选择器。只需填写一个简单的 CSS 选择器,如 #title h1,即可准确地采集 网页上的任何内容。 (如何设置 CSS 选择器)

支持设置关键词,如果标题收录关键词,则只允许采集(或过滤掉采集不允许)。

支持设置多条匹配规则采集网页不同内容,甚至支持采集任意内容添加到“WordPress自定义栏目”中,方便扩展。

基础设置齐全,完美支持Wordpress的各种功能。可自动设置分类、标签、摘要、特色图片、自定义栏目等;还可以发布采集target网站的分类、标签等信息,可以自动生成并添加对应的分类目录、标签等信息

每个采集任务可以选择发布到的类别、发布作者、发布状态、查看和更新时间间隔、采集target网站字符集、选择是否下载图片或附件。

支持自定义文章类型、自定义文章类别、文章表单。

完美支持Wordpress各种功能,自动添加标签,自动生成摘要,自动设置特色图片,支持自定义栏目等

采集微信公号、头条号等自媒体内容,因为百度没有收录公号、头条文章等,轻松获取优质“原创” 文章,加百度收录量和网站权重

支持采集微信公号(订阅号)文章,无需复杂配置,只需填写“公众号”和“微信ID”即可启动采集。

支持采集今日头条文章无需复杂配置

支持谷歌神经网络翻译、有道神经网络翻译、百度翻译,将文章翻译成其他语言,轻松搞定原创文章

支持谷歌神经网络翻译,翻译质量得到显着提升,接近人工翻译效果。 文章title和内容翻译成其他语言,支持多语言互译。 原创文章 很容易获得。使用谷歌翻译API无需翻墙,翻墙获取API相关设置信息即可正常使用,使用时无需翻墙稍后调用 API 翻译

支持有道神经网络翻译,接近人工翻译效果,有道翻译更懂中文,采集中文文章translate成中文文章,轻松搞定原创文章。

同时支持百度翻译。百度翻译月翻译字200万以内,享受免费服务

支持多种伪原创中英文方法

支持使用翻译引擎获取伪原创文章,不仅替换同义词,还重述语义。唯一性和伪原创更好,支持多种语言。同时集成了国外最好的伪原创工具WordAi等,使得一个英文站可以获得更具可读性和独特性的伪原创文章。

远程图片和其他任何格式的附件均可下载到本地服务器,并自动给图片添加水印

支持远程图片下载到本地服务器,可以选择自动添加文字水印或图片水印。任何其他格式的附件和文档也可以轻松下载到本地服务器。

支持市面上所有主流的对象存储服务,包括七牛云、阿里云OSS、腾讯云COS、百度云BOS、优派云、亚马逊AWS S3、Google云存储、文章中图片及附件自动上传到云对象存储服务,节省带宽和空间,提高网站访问速度

七牛云存储,每月10GB免费存储空间,10GB免费带宽流量

只需简单配置相关信息,即可自动上传,并可通过Wordpress后台直接查看或管理上传至云对象存储的图片和文件。

支持SEO优化、内容过滤、HTML标签过滤、关键词替换、自动添加链接、添加自定义内容、自定义采集帖子样式、自定义模板等常用功能

自动删除采集内容中的HTML注释,可以设置删除标签中的id、class、style属性内容,消除采集的痕迹;自动给图片添加alt属性,过滤链接,替换关键词,自动添加自定义链接,这些都有利于SEO。

支持内容过滤,过滤不想发布的采集内容(如广告代码、文章source、版权等信息),甚至可以在文章任意位置添加自定义内容进行增强文章唯一性;也可以设置采集后添加自定义样式功能

还支持HTML标签过滤功能,可以过滤掉采集文章中的超链接、script和style标签下不需要的代码。

本资源下载价格为1金币,请先登录

☆下载协议☆下载前请阅读本协议。如果您已下载,本站将视为您已阅读并接受以下协议。

1. 下载内容不收录其技术服务。小白不建议下载。如果您需要在本站提供有偿技术服务,请联系我们。

2.本站所有资源均来自互联网,版权归原作者所有,请保留原版权信息。

3.本站分享仅供参考、学习和演示。不保证一切都能正常演示,也不能保证授权和破解。因此,不支持下载内容后的所有争议。请自行选择下载。

4.如果你抱着下载可以直接正常使用的心态,请跳过,建议不要下载。如需商业用途,请选择官方渠道购买正版!

资源下载

下载价格:1金币

VIP 折扣:免费

☆下载协议☆下载前请阅读本协议。如果您已下载,本站将视为您已阅读并接受以下协议。

1. 下载内容不收录其技术服务。小白不建议下载。如果您需要在本站提供有偿技术服务,请联系我们。

2.本站所有资源均来自互联网,版权归原作者所有,请保留原版权信息。

3.本站分享仅供参考、学习和演示。不保证一切都能正常演示,也不能保证授权和破解。因此,不支持下载内容后的所有争议。请自行选择下载。

4.如果你抱着下载可以直接正常使用的心态,请跳过,建议不要下载。如需商业用途,请选择官方渠道购买正版!

关键词文章采集源码(机器翻译测试在用python自动生成模型的新论文下载总结)

采集交流 • 优采云 发表了文章 • 0 个评论 • 151 次浏览 • 2021-09-01 15:01

关键词文章采集源码下载总结·中国论文速递公众号最近,出现一篇关于“机器翻译测试在用python自动生成模型”的新论文,很多博客都推荐这篇文章。接下来,小弟就对论文里的recursivewordembedding进行搜索和实现,记录下来。网上包括知乎已经有大量的python爬虫爬取数据,但文章中需要在自己的模型前加上--recursive,,这样会被谷歌识别为文章的重复,所以这里用更浅显易懂的话讲讲python中的recursivewordembedding算法和transformer机器翻译系统是如何合并得到每一个词与下一个词的映射,并且处理文章中一些注释需要产生一些多余的词。

recursivewordembeddingrecursivewordembedding算法其实本质上也是要求词和词之间保持一定的对应关系,其实本质算是“词袋模型”中的“词嵌入”(black-dressedmodel)。从“词嵌入”的定义来看,词嵌入就是把每个词嵌入到向量空间中,其中:线性向量:常见的词向量模型有cbow(skip-gram),semi-supervisedgenerativeadversarialnetwork,cosmographicalfeature等。

negativeencodings:本文用python通过编写一个python程序自动生成一个用于词汇级别的偏词向量(biasedwordembedding)。训练过程使用python语言的rnn作为输入来自动生成一个训练过程中模型的单词,其中用于训练的最小单词具有公共配对。先看下downloadtheencoderframework,withoutthedistributiontoconcatenatethedatabetweenwords.代码实现先分析代码结构,所以定义这段话:defcodegen(inputstr,outputstr):ifoutputstr.count()wordword->separate('-')temp->transifdim(true)intrans:word=wordifsameword==transandtrans==outputstr:temp=int(trans)word->wordelse:word=samewordreturntemp字典treetree=[]["tree1","tree2"]fornameininputstr:defpopulateword(name):returndefforwardstring(s...):tree=generateword(s...)tree=int(tree)returntree接下来看下parser进行wordembedding,有了词嵌入训练出来的单词词向量(后边会将词嵌入转换成词向量,有时候也可以加上one-hotencoding方法,此处不做过多分析,可以参考此文)。最终,可以得到第二个词的词向量用。 查看全部

关键词文章采集源码(机器翻译测试在用python自动生成模型的新论文下载总结)

关键词文章采集源码下载总结·中国论文速递公众号最近,出现一篇关于“机器翻译测试在用python自动生成模型”的新论文,很多博客都推荐这篇文章。接下来,小弟就对论文里的recursivewordembedding进行搜索和实现,记录下来。网上包括知乎已经有大量的python爬虫爬取数据,但文章中需要在自己的模型前加上--recursive,,这样会被谷歌识别为文章的重复,所以这里用更浅显易懂的话讲讲python中的recursivewordembedding算法和transformer机器翻译系统是如何合并得到每一个词与下一个词的映射,并且处理文章中一些注释需要产生一些多余的词。

recursivewordembeddingrecursivewordembedding算法其实本质上也是要求词和词之间保持一定的对应关系,其实本质算是“词袋模型”中的“词嵌入”(black-dressedmodel)。从“词嵌入”的定义来看,词嵌入就是把每个词嵌入到向量空间中,其中:线性向量:常见的词向量模型有cbow(skip-gram),semi-supervisedgenerativeadversarialnetwork,cosmographicalfeature等。

negativeencodings:本文用python通过编写一个python程序自动生成一个用于词汇级别的偏词向量(biasedwordembedding)。训练过程使用python语言的rnn作为输入来自动生成一个训练过程中模型的单词,其中用于训练的最小单词具有公共配对。先看下downloadtheencoderframework,withoutthedistributiontoconcatenatethedatabetweenwords.代码实现先分析代码结构,所以定义这段话:defcodegen(inputstr,outputstr):ifoutputstr.count()wordword->separate('-')temp->transifdim(true)intrans:word=wordifsameword==transandtrans==outputstr:temp=int(trans)word->wordelse:word=samewordreturntemp字典treetree=[]["tree1","tree2"]fornameininputstr:defpopulateword(name):returndefforwardstring(s...):tree=generateword(s...)tree=int(tree)returntree接下来看下parser进行wordembedding,有了词嵌入训练出来的单词词向量(后边会将词嵌入转换成词向量,有时候也可以加上one-hotencoding方法,此处不做过多分析,可以参考此文)。最终,可以得到第二个词的词向量用。

关键词文章采集源码(帝国CMS7.5自适应Office教程网电脑技巧文章资讯)

采集交流 • 优采云 发表了文章 • 0 个评论 • 146 次浏览 • 2021-08-30 00:09

Empirecms7.5自适应办公教程网络电脑技巧文章资讯带PPT、Word、Excel模板下载功能+采集+百度推送+sitemap+itag全站源码

———————————————————————————————————

PC/电脑版演示地址:

WAP/手机版演示地址:(请使用手机访问)

(演示站点仅采集填充页面部分数据看效果,以后可以使用自己的采集器采集大量数据)

———————————————————————————————————

本模板由业主自己制作、模仿和移植。店主一直致力于为您提供各类优质、易用、物美价廉的模板。感谢您的支持!

所有功能都在后台管理。

模板使用标签灵活调用,采集精选优质源站,模板精美同时兼顾SEO搜索引擎优化。

全站静态生成有利于收录和关键词布局和内容页面优化!

功能列表:

使用新的 Empirecms7.5 核心版本。列和内容模板是超级多变的。后台操作简单,安全可靠,性能稳定。全站响应式手机、平板浏览,高端大气,快速搭建自己的网站!

1、内置东坡ITAG超级管理插件,关键词可动可静可伪静态,tag关键词可设置ID或拼音显示,超多玩法,更优化!

2、内置东坡多功能推送插件,数据更新后,通过百度API接口实时推送到百度,收录速度更快,效果极佳!

3、Built-in Sitemap 百度地图生成插件,基于百度新的2.0技术标准,代码简洁规范,更有利于百度数据的抓取。

4、Adaptive wap移动端,省时省力,简单方便。

其他具体细节不再一一赘述。如需了解,可直接访问演示站点。

———————————————————————————————————————

●帝国cms7.5UTF-8

●系统开源,域名不限。

●独立的WAP移动端简单实用,有利于SEO优化

●全站数据1.5GB左右

●简单的安装方法,详细的安装教程。

●通过优采云采集器,你可以自己设置大量数据采集,也可以自动化一张采集。

———————————————————————————————————————

此源代码包括一次性免费安装服务。安装完成。如因个人原因需要重新安装,请另行支付安装费。

此源代码保证与演示站点相同。店主很忙,制作模板又兼顾售后服务,所以不提供免费模板修改服务。

如果您需要定制、修改、二次开发等任务,请单独联系我。

注:购买正版源码请到“”购买,或在本站搜索相关资源! 查看全部

关键词文章采集源码(帝国CMS7.5自适应Office教程网电脑技巧文章资讯)

Empirecms7.5自适应办公教程网络电脑技巧文章资讯带PPT、Word、Excel模板下载功能+采集+百度推送+sitemap+itag全站源码

———————————————————————————————————

PC/电脑版演示地址:

WAP/手机版演示地址:(请使用手机访问)

(演示站点仅采集填充页面部分数据看效果,以后可以使用自己的采集器采集大量数据)

———————————————————————————————————

本模板由业主自己制作、模仿和移植。店主一直致力于为您提供各类优质、易用、物美价廉的模板。感谢您的支持!

所有功能都在后台管理。

模板使用标签灵活调用,采集精选优质源站,模板精美同时兼顾SEO搜索引擎优化。

全站静态生成有利于收录和关键词布局和内容页面优化!

功能列表:

使用新的 Empirecms7.5 核心版本。列和内容模板是超级多变的。后台操作简单,安全可靠,性能稳定。全站响应式手机、平板浏览,高端大气,快速搭建自己的网站!

1、内置东坡ITAG超级管理插件,关键词可动可静可伪静态,tag关键词可设置ID或拼音显示,超多玩法,更优化!

2、内置东坡多功能推送插件,数据更新后,通过百度API接口实时推送到百度,收录速度更快,效果极佳!

3、Built-in Sitemap 百度地图生成插件,基于百度新的2.0技术标准,代码简洁规范,更有利于百度数据的抓取。

4、Adaptive wap移动端,省时省力,简单方便。

其他具体细节不再一一赘述。如需了解,可直接访问演示站点。

———————————————————————————————————————

●帝国cms7.5UTF-8

●系统开源,域名不限。

●独立的WAP移动端简单实用,有利于SEO优化

●全站数据1.5GB左右

●简单的安装方法,详细的安装教程。

●通过优采云采集器,你可以自己设置大量数据采集,也可以自动化一张采集。

———————————————————————————————————————

此源代码包括一次性免费安装服务。安装完成。如因个人原因需要重新安装,请另行支付安装费。

此源代码保证与演示站点相同。店主很忙,制作模板又兼顾售后服务,所以不提供免费模板修改服务。

如果您需要定制、修改、二次开发等任务,请单独联系我。

注:购买正版源码请到“”购买,或在本站搜索相关资源!

关键词文章采集源码(php开源问答系统简介及更新日志问答软件简介 )

采集交流 • 优采云 发表了文章 • 0 个评论 • 133 次浏览 • 2021-08-30 00:08

)

软件介绍

Whatsns问答系统(原ask2问答系统)是一款PHP开源问答系统,可以根据自身业务需求快速搭建垂直领域。内置强大的采集功能,支持云存储、图片水印设置、全文检索、站内行为监控、短信注册和通知、伪静态URL自定义、熊掌号功能、百度结构化地图(标签、问题、文章、分类、用户空间),PC 和 Wap 模板分离,内置多套 pc 和 Wap 模板,站长可以自由切换。同时后台支持模板管理、模板在线编辑修改、强大的反灌拦截过滤配置等数百项功能,深度SEO优化,适合需要SEO的站长。商业版还支持优采云采集,先进的微信公众号接口功能,支持支付宝支付、微信扫码支付、微信JSSDK支付、微信H5支付、小程序支付,以及适合不同场景的支付服务,如作为充值和呼叫奖励,回答偷看,并咨询付费专家。

优点:

1、基于独立的MVC框架开发,框架结构清晰,易于维护,模块化,扩展性好,性能稳定。

2、支持Ucenter、Xunseach、cms等系统集成,方便易用。

3、 简单易懂的模板语法,让前端人员独立完成模板创建和数据调用。

4、Station seo 优化很不错

5、内置文章功能,每个用户都可以发布自己文章

6、程序内置超强Q&A采集功能,无需编写知名Q&A网站rules,一键采集千万条数据,新站快丰富网站content

7、内置强大的自动标签识别功能,题和题采集都能识别关键词

8、强大的搜索系统,搜索问题可以通过输入字符串的全文进行搜索,如果搜索不通过进入关键词搜索,如果搜索不通过可以转换成模糊搜索,可以列出相关问题

政府机关、教育机构、事业单位、商业企业、个人站长均可使用。

2018-12-05 更新日志

1 在后台标签管理中添加一批要插入的标签

2 pc端添加好友链功能

3 将手机端的frozewap模板调整为绿色样式并修改UI效果

4 PC UI配色及列表显示效果调整

5 修复 ueditor 回答时提示内容为空的问题

6 文章Delayed loading 统一采用内容加载

查看全部

关键词文章采集源码(php开源问答系统简介及更新日志问答软件简介

)

软件介绍

Whatsns问答系统(原ask2问答系统)是一款PHP开源问答系统,可以根据自身业务需求快速搭建垂直领域。内置强大的采集功能,支持云存储、图片水印设置、全文检索、站内行为监控、短信注册和通知、伪静态URL自定义、熊掌号功能、百度结构化地图(标签、问题、文章、分类、用户空间),PC 和 Wap 模板分离,内置多套 pc 和 Wap 模板,站长可以自由切换。同时后台支持模板管理、模板在线编辑修改、强大的反灌拦截过滤配置等数百项功能,深度SEO优化,适合需要SEO的站长。商业版还支持优采云采集,先进的微信公众号接口功能,支持支付宝支付、微信扫码支付、微信JSSDK支付、微信H5支付、小程序支付,以及适合不同场景的支付服务,如作为充值和呼叫奖励,回答偷看,并咨询付费专家。

优点:

1、基于独立的MVC框架开发,框架结构清晰,易于维护,模块化,扩展性好,性能稳定。

2、支持Ucenter、Xunseach、cms等系统集成,方便易用。

3、 简单易懂的模板语法,让前端人员独立完成模板创建和数据调用。

4、Station seo 优化很不错

5、内置文章功能,每个用户都可以发布自己文章

6、程序内置超强Q&A采集功能,无需编写知名Q&A网站rules,一键采集千万条数据,新站快丰富网站content

7、内置强大的自动标签识别功能,题和题采集都能识别关键词

8、强大的搜索系统,搜索问题可以通过输入字符串的全文进行搜索,如果搜索不通过进入关键词搜索,如果搜索不通过可以转换成模糊搜索,可以列出相关问题

政府机关、教育机构、事业单位、商业企业、个人站长均可使用。

2018-12-05 更新日志

1 在后台标签管理中添加一批要插入的标签

2 pc端添加好友链功能

3 将手机端的frozewap模板调整为绿色样式并修改UI效果

4 PC UI配色及列表显示效果调整

5 修复 ueditor 回答时提示内容为空的问题

6 文章Delayed loading 统一采用内容加载

关键词文章采集源码(快克SEO是良心商家,从来不坑穷人和聪明人!)

采集交流 • 优采云 发表了文章 • 0 个评论 • 162 次浏览 • 2021-08-29 17:01

前言

最近有不少网友表示破解是个坑,尤其是破解的搜狗推送工具。 1888元买的用处不大。

其实,曹操觉得快克是个好人。他每次都免费给我工具和模板,而且他从来没有没收过我的钱。

我想为此发声:Crack SEO 是一门良心的生意,从不欺骗穷人和聪明人!我付钱买了一些破解!

而且免费的工具很多,界面也很漂亮。老实说,我和韭菜没有关系。

截图

工具特性

本工具全部免费,根据关键词抓取搜索引擎的URL信息;

抓取速度快,秒杀市面上同类工具;

同时支持本地和代理模式;

可自由配置并打开更多窗口;

使用说明

导入关键词,标题必须收录输入框(no or nothing),即标题必须收录输入框列表中的一项;

过滤域名输入框(如果没有就留空),一些大的正规站点默认过滤,也就是说如果域名是输入框列表或者它的子域之一,它将被过滤;

抓取的页面数是指抓取搜索引擎的前几页;

自动去重域名,如果域名重复,会被过滤;

该工具支持百度、搜狗、360、谷歌四大主流搜索引擎,后期可以添加;

百度本地模式就好,一般情况下不需要代理,可以根据网速调整设置,降低失败率;

搜狗、360、谷歌等搜索引擎的反爬虫比较严格。一个IP可以搜索几十到几百个字。使用后,IP会被限制,一段时间后会继续爬取;

如果关键词不是很多,用VPN切换IP,每次爬上几十到几百个字后,再切换IP;

如果要大量关键词无间隙查询,需要购买代理IP(配置见附图)

一般情况下,您可以使用默认配置。如果查询失败,可以调整设置,减少线程数,增加超时时间;

增加自动故障复查次数,同时增加延迟爬行时间;

一般来说,减少搜索引擎同时抓取的次数,或者增加自动故障复查次数是一个原则;

代理IP目前只支持E-change代理(URL:),如果你有性能更好的代理IP;

请发给我,添加多个接口,免费为用户升级。

代理IP提取方法会同步软件包截图教程。建议一次提取一个IP,以节省IP使用。 查看全部

关键词文章采集源码(快克SEO是良心商家,从来不坑穷人和聪明人!)

前言

最近有不少网友表示破解是个坑,尤其是破解的搜狗推送工具。 1888元买的用处不大。

其实,曹操觉得快克是个好人。他每次都免费给我工具和模板,而且他从来没有没收过我的钱。

我想为此发声:Crack SEO 是一门良心的生意,从不欺骗穷人和聪明人!我付钱买了一些破解!

而且免费的工具很多,界面也很漂亮。老实说,我和韭菜没有关系。

截图

工具特性

本工具全部免费,根据关键词抓取搜索引擎的URL信息;

抓取速度快,秒杀市面上同类工具;

同时支持本地和代理模式;

可自由配置并打开更多窗口;

使用说明

导入关键词,标题必须收录输入框(no or nothing),即标题必须收录输入框列表中的一项;

过滤域名输入框(如果没有就留空),一些大的正规站点默认过滤,也就是说如果域名是输入框列表或者它的子域之一,它将被过滤;

抓取的页面数是指抓取搜索引擎的前几页;

自动去重域名,如果域名重复,会被过滤;

该工具支持百度、搜狗、360、谷歌四大主流搜索引擎,后期可以添加;

百度本地模式就好,一般情况下不需要代理,可以根据网速调整设置,降低失败率;

搜狗、360、谷歌等搜索引擎的反爬虫比较严格。一个IP可以搜索几十到几百个字。使用后,IP会被限制,一段时间后会继续爬取;

如果关键词不是很多,用VPN切换IP,每次爬上几十到几百个字后,再切换IP;

如果要大量关键词无间隙查询,需要购买代理IP(配置见附图)

一般情况下,您可以使用默认配置。如果查询失败,可以调整设置,减少线程数,增加超时时间;

增加自动故障复查次数,同时增加延迟爬行时间;

一般来说,减少搜索引擎同时抓取的次数,或者增加自动故障复查次数是一个原则;

代理IP目前只支持E-change代理(URL:),如果你有性能更好的代理IP;

请发给我,添加多个接口,免费为用户升级。

代理IP提取方法会同步软件包截图教程。建议一次提取一个IP,以节省IP使用。

关键词文章采集源码(【平安二号·百日攻坚】新建一个站点的设定)

采集交流 • 优采云 发表了文章 • 0 个评论 • 127 次浏览 • 2021-08-29 11:08

在您需要的类别下新建站点,或者在您需要的类别下新建站点,或者如果任务是任务,点击试点添加然后输入网址添加,点击试点添加然后输入网址添加通过百度找到最合适的医院网址。通过百度找到最合适的医院网址。找到你需要的网址文章List页面 找到你需要的网址文章List页面 添加网址并点击最后一页并点击最后一页 添加此网址 添加此网址 将疯狂部分添加为通配符 将疯狂部分添加为通配符 填写完毕后,点击添加,点击添加。添加完成后,点击完成添加,点击完成。然后到本网页文章List页面中的源代码,再到本网页文章List页面中的源代码中寻找与红框内代码类似的代码。查找与红色框中的代码类似的代码。使用搜索功能确认此代码是唯一的。使用搜索功能确认此代码为唯一代码,不重复。文章List 代码,不重复,在需要采集 的文章 列表之前在此处添加header 代码。在此处添加标题代码。找到源文件中文章List 页面末尾的代码。去源文件找到列表页末尾的代码文章这是列表页文章底部这是列表页文章底部在这个搜索底部找到不重复的代码 确认搜索方法并填写以上信息。确认无误后,点击以上信息确认,点击“点击启动测试网络,点击启动测试网址采集Address采集”采集网址出现在红框内 仅当小标记出现在URL采集采集,红框中的小标记被认为是采集 成功点击红框中的任意一个URL,然后继续文章打开红框中的任意一个URL。做文章content设置 内容设置 双击URL进入 双击URL进入 然后点击Test 然后点击Test文章Content 出现文章Content 双击内容设置content文章content 也输入文章content 也搜索源代码搜索源代码搜索文章前部代码,和文章尾部代码查询文章前部代码,和文章尾部代码然后点击确定然后单击“确定”,然后再次单击“测试”检查是否成功排除,然后再次单击“测试”检查其他代码是否成功排除。其他代码得到的结果是这样的。得到的结果是这样的。再次点击内容可替换内容,例如再次点击内容。进行内容替换,例如替换医院名称,将区域名称改为医院名称,区域名称,然后点击保存文件,然后点击保存文件保存到需要修改的网盘保存 保存到需要保存的网盘 设置完成后点击保存设置,点击保存设置,可以直接跳转到首页。设置后可以跳转到首页点击之前设置的任务,点击开始,然后点击之前设置的任务,点击开始,启动任务采集启动任务采集然后等待文章 采集 然后等待文章采集文章采集 完成后会出现类似这样的提示文章采集 出现这样的提示时,大家可以关闭优采云,直接去安检,然后大家可以关闭优采云,直接去保存的文档找文章里存的文档找文章里 查看全部

关键词文章采集源码(【平安二号·百日攻坚】新建一个站点的设定)

在您需要的类别下新建站点,或者在您需要的类别下新建站点,或者如果任务是任务,点击试点添加然后输入网址添加,点击试点添加然后输入网址添加通过百度找到最合适的医院网址。通过百度找到最合适的医院网址。找到你需要的网址文章List页面 找到你需要的网址文章List页面 添加网址并点击最后一页并点击最后一页 添加此网址 添加此网址 将疯狂部分添加为通配符 将疯狂部分添加为通配符 填写完毕后,点击添加,点击添加。添加完成后,点击完成添加,点击完成。然后到本网页文章List页面中的源代码,再到本网页文章List页面中的源代码中寻找与红框内代码类似的代码。查找与红色框中的代码类似的代码。使用搜索功能确认此代码是唯一的。使用搜索功能确认此代码为唯一代码,不重复。文章List 代码,不重复,在需要采集 的文章 列表之前在此处添加header 代码。在此处添加标题代码。找到源文件中文章List 页面末尾的代码。去源文件找到列表页末尾的代码文章这是列表页文章底部这是列表页文章底部在这个搜索底部找到不重复的代码 确认搜索方法并填写以上信息。确认无误后,点击以上信息确认,点击“点击启动测试网络,点击启动测试网址采集Address采集”采集网址出现在红框内 仅当小标记出现在URL采集采集,红框中的小标记被认为是采集 成功点击红框中的任意一个URL,然后继续文章打开红框中的任意一个URL。做文章content设置 内容设置 双击URL进入 双击URL进入 然后点击Test 然后点击Test文章Content 出现文章Content 双击内容设置content文章content 也输入文章content 也搜索源代码搜索源代码搜索文章前部代码,和文章尾部代码查询文章前部代码,和文章尾部代码然后点击确定然后单击“确定”,然后再次单击“测试”检查是否成功排除,然后再次单击“测试”检查其他代码是否成功排除。其他代码得到的结果是这样的。得到的结果是这样的。再次点击内容可替换内容,例如再次点击内容。进行内容替换,例如替换医院名称,将区域名称改为医院名称,区域名称,然后点击保存文件,然后点击保存文件保存到需要修改的网盘保存 保存到需要保存的网盘 设置完成后点击保存设置,点击保存设置,可以直接跳转到首页。设置后可以跳转到首页点击之前设置的任务,点击开始,然后点击之前设置的任务,点击开始,启动任务采集启动任务采集然后等待文章 采集 然后等待文章采集文章采集 完成后会出现类似这样的提示文章采集 出现这样的提示时,大家可以关闭优采云,直接去安检,然后大家可以关闭优采云,直接去保存的文档找文章里存的文档找文章里

关键词文章采集源码(微信文章抓取工具详细使用方法_微信优采云·云采集服务平台工具)

采集交流 • 优采云 发表了文章 • 0 个评论 • 126 次浏览 • 2021-08-29 11:07

微信文章Grabber工具详细使用方法_微信WeChat文章Grabber工具详细使用方法_微信优采云·云采集服务平台爬虫工具详细使用方法现在越来越优质的内容是发布在微信公众号上。面对这些内容,有的朋友有下载采集的需求。这里介绍使用优采云Grabber 工具抓取采集微信文章信息。抓取的内容包括:微信文章title、微信文章关键词、微信文章部分内容展示、微信公众号、微信文章发布时间、微信文章URL等字段数据。 采集网站:第一步:创建采集task1)进入主界面,选择“自定义模式”优采云·云采集服务平台2)将要采集 URL URL复制粘贴进入网站输入框点击“保存网址”优采云·云采集服务平台爬虫工具详细使用步骤2步骤2:创建翻页循环1)页面右上角,打开“流程”,以显示“流程设计器”和“自定义当前操作”两部分。点击页面文章搜索框,在右侧操作提示框中选择“输入文字”优采云·云采集服务平台抓取工具详细使用步骤32)输入文章你要搜索@信息,这里以搜索“优采云大数据”为例,输入完成后点击“确定”按钮微信文章抓取工具详细使用步骤4优采云·云采集服务平台3)“优采云大数据”会自动填入搜索框,点击“search文章”按钮,在操作提示框中选择“点击此按钮”微信文章抓取工具详细使用步骤54)页面出现了文章“优采云大数据”的搜索结果。

将结果页面下拉到最下方,点击“下一页”按钮,在右侧操作提示框中选择“循环点击下一页”优采云·云采集服务平台Grabbing详细使用工具 Step 6 Step 3:创建列表循环并提取数据1) 移动鼠标选择页面上的第一个文章块。系统会识别该区块中的子元素,在操作提示框中选择“选择子元素”优采云·云采集服务平台爬虫工具详细使用步骤72)继续选择第二部分页面文章的块,系统会自动选择第二条文章的子元素,并识别页面上其他10组相似元素,在操作提示框中选择“全选”微信文章Grab 获取工具详细使用步骤8优采云·云采集服务平台3) 可以看到页面上文章块中的所有元素都被选中并变绿了。在右侧的操作提示框中,会出现一个字段预览表。将鼠标移动到表头并单击垃圾桶图标以删除不需要的字段。字段选择完成后,选择“采集以下数据”微信文章抓取工具详细使用步骤94)既然我们也想要采集each文章URL,那么我们还需要提取一个字段。点击第一篇文章文章的链接,再点击第二篇文章文章的链接,系统会自动在页面上选择一组文章链接。在右侧操作提示框中选择“采集以下链接地址”优采云·云采集服务平台爬虫工具详细使用步骤105)字段选择完成后,选择对应的字段,可以输入字段自定义命名。完成后点击左上角“保存并启动”启动采集Task微信文章Grabbing工具。详细使用步骤116)选择“启动local采集”优采云·云采集服务平台爬虫工具的详细使用步骤12步骤4:数据采集和导 查看全部

关键词文章采集源码(微信文章抓取工具详细使用方法_微信优采云·云采集服务平台工具)

微信文章Grabber工具详细使用方法_微信WeChat文章Grabber工具详细使用方法_微信优采云·云采集服务平台爬虫工具详细使用方法现在越来越优质的内容是发布在微信公众号上。面对这些内容,有的朋友有下载采集的需求。这里介绍使用优采云Grabber 工具抓取采集微信文章信息。抓取的内容包括:微信文章title、微信文章关键词、微信文章部分内容展示、微信公众号、微信文章发布时间、微信文章URL等字段数据。 采集网站:第一步:创建采集task1)进入主界面,选择“自定义模式”优采云·云采集服务平台2)将要采集 URL URL复制粘贴进入网站输入框点击“保存网址”优采云·云采集服务平台爬虫工具详细使用步骤2步骤2:创建翻页循环1)页面右上角,打开“流程”,以显示“流程设计器”和“自定义当前操作”两部分。点击页面文章搜索框,在右侧操作提示框中选择“输入文字”优采云·云采集服务平台抓取工具详细使用步骤32)输入文章你要搜索@信息,这里以搜索“优采云大数据”为例,输入完成后点击“确定”按钮微信文章抓取工具详细使用步骤4优采云·云采集服务平台3)“优采云大数据”会自动填入搜索框,点击“search文章”按钮,在操作提示框中选择“点击此按钮”微信文章抓取工具详细使用步骤54)页面出现了文章“优采云大数据”的搜索结果。

将结果页面下拉到最下方,点击“下一页”按钮,在右侧操作提示框中选择“循环点击下一页”优采云·云采集服务平台Grabbing详细使用工具 Step 6 Step 3:创建列表循环并提取数据1) 移动鼠标选择页面上的第一个文章块。系统会识别该区块中的子元素,在操作提示框中选择“选择子元素”优采云·云采集服务平台爬虫工具详细使用步骤72)继续选择第二部分页面文章的块,系统会自动选择第二条文章的子元素,并识别页面上其他10组相似元素,在操作提示框中选择“全选”微信文章Grab 获取工具详细使用步骤8优采云·云采集服务平台3) 可以看到页面上文章块中的所有元素都被选中并变绿了。在右侧的操作提示框中,会出现一个字段预览表。将鼠标移动到表头并单击垃圾桶图标以删除不需要的字段。字段选择完成后,选择“采集以下数据”微信文章抓取工具详细使用步骤94)既然我们也想要采集each文章URL,那么我们还需要提取一个字段。点击第一篇文章文章的链接,再点击第二篇文章文章的链接,系统会自动在页面上选择一组文章链接。在右侧操作提示框中选择“采集以下链接地址”优采云·云采集服务平台爬虫工具详细使用步骤105)字段选择完成后,选择对应的字段,可以输入字段自定义命名。完成后点击左上角“保存并启动”启动采集Task微信文章Grabbing工具。详细使用步骤116)选择“启动local采集”优采云·云采集服务平台爬虫工具的详细使用步骤12步骤4:数据采集和导

关键词文章采集源码(优采云采集器的采集方法及步骤(一)_数据分析采集器)

采集交流 • 优采云 发表了文章 • 0 个评论 • 158 次浏览 • 2021-08-29 06:01

目的:用于数据分析

使用工具:优采云采集器(优采云采集器是一款互联网数据采集、处理、分析、挖掘软件。)

二、采集方法步骤说明####

第一步:安装优采云采集器(注意:需要安装net4.0框架才能运行)

优采云采集器下载链接:

第 2 步:注册帐户

第三步:了解基本界面

一个。点击开始 -> 创建一个新文件夹(并重命名它以便你知道采集 是什么) -> 创建一个新任务

B.创建新任务后,会弹出设置任务规则的对话框(注意以下几点)

(1)填写你想要采集的内容所在的URL。如果是常规的,可以使用【添加向导】相关规则,如下:以短书为例,我要采集自己简书内容数据与分析采集的主要内容在列表页,但是因为短书采用了懒加载的方式,无法采集翻页的内容,所以需要查看源代码(这里需要了解一些代码知识,只有童鞋才能找到),然后在源代码中找到相关的链接,都是有规律的,所以我可以通过【添加向导】添加相关规则。对于具体规则,继续看以下步骤4.

向导添加界面:

第 4 步:编写 URL 提取规则

我在源代码中找到了列表链接。如果你想要采集所有的链接,你必须找出所有的翻页。翻页是有规律的,所以我得到了以下规则。只是链接中“page=”后面的地址参数改变了,所以我们可以用【地址参数】来设置参数。然后在[地址参数]中选择数字变化,因为它是一个数字。一共有14个项目,所以有14个项目。

设置好地址格式后,我们可以在这个页面进一步设置我们想要采集的内容。即我们需要传递列表页的URL采集each文章,方法如下:

(1)获取内容URL时,选择获取方式:自动获取地址链接。

(2)使用链接过滤:提取文章链接,文章链接常见。

这些填好后点击【URL采集TEST】,此时可以验证规则是否正确。

验证OK!规则是对的!伟大的!规则写好后记得保存!

第五步:编写内容抽取规则

采集到达每个文章的网址后,接下来我们需要的是采集each文章相关信息:标题、网址、阅读数、点赞数!这是我们的终极目标!规则写好后记得保存哦!方法如下图所示:

PS:这也需要一些html代码的知识。

添加规则如下:

(1)在标签列表中为采集添加标签名称,方框右侧有“+”可以添加多个标签。

(2)数据获取方式选择:从源码中获取数据,选择提取方式“截取前后”,然后在源码中提取我们想要的信息的前后码。记住,如果它是唯一的代码,请避免提取出错。

补充:教你提取前后代码

在网页中,右击查看源代码。找到标题。我们会发现有多个重复的标题。但是要选择code前后的唯一一个,可以通过ctrl+f来验证是否唯一。下面是标题前后的代码,剩下几个元素前后的代码,大家可以自己练习。

第六步:设置存储位置

点击内容发布规则——>另存为本地文件——>启用本地文件保存——>保存设置文件格式选择txt(因为我们使用的是免费软件)——>设置保存位置

第七步:启动采集,设置存储位置和设置规则,保存退出,返回工具首页,启动采集——>这3个地方一定要勾选,然后右键选择—— >开始。见下图:

采集之后的初步数据:

呈现清洗后的数据及相关数据分析,见下图:

三、个人经验总结#### 查看全部

关键词文章采集源码(优采云采集器的采集方法及步骤(一)_数据分析采集器)

目的:用于数据分析

使用工具:优采云采集器(优采云采集器是一款互联网数据采集、处理、分析、挖掘软件。)

二、采集方法步骤说明####

第一步:安装优采云采集器(注意:需要安装net4.0框架才能运行)

优采云采集器下载链接:

第 2 步:注册帐户

第三步:了解基本界面

一个。点击开始 -> 创建一个新文件夹(并重命名它以便你知道采集 是什么) -> 创建一个新任务

B.创建新任务后,会弹出设置任务规则的对话框(注意以下几点)

(1)填写你想要采集的内容所在的URL。如果是常规的,可以使用【添加向导】相关规则,如下:以短书为例,我要采集自己简书内容数据与分析采集的主要内容在列表页,但是因为短书采用了懒加载的方式,无法采集翻页的内容,所以需要查看源代码(这里需要了解一些代码知识,只有童鞋才能找到),然后在源代码中找到相关的链接,都是有规律的,所以我可以通过【添加向导】添加相关规则。对于具体规则,继续看以下步骤4.

向导添加界面:

第 4 步:编写 URL 提取规则

我在源代码中找到了列表链接。如果你想要采集所有的链接,你必须找出所有的翻页。翻页是有规律的,所以我得到了以下规则。只是链接中“page=”后面的地址参数改变了,所以我们可以用【地址参数】来设置参数。然后在[地址参数]中选择数字变化,因为它是一个数字。一共有14个项目,所以有14个项目。

设置好地址格式后,我们可以在这个页面进一步设置我们想要采集的内容。即我们需要传递列表页的URL采集each文章,方法如下:

(1)获取内容URL时,选择获取方式:自动获取地址链接。

(2)使用链接过滤:提取文章链接,文章链接常见。

这些填好后点击【URL采集TEST】,此时可以验证规则是否正确。

验证OK!规则是对的!伟大的!规则写好后记得保存!

第五步:编写内容抽取规则

采集到达每个文章的网址后,接下来我们需要的是采集each文章相关信息:标题、网址、阅读数、点赞数!这是我们的终极目标!规则写好后记得保存哦!方法如下图所示:

PS:这也需要一些html代码的知识。

添加规则如下:

(1)在标签列表中为采集添加标签名称,方框右侧有“+”可以添加多个标签。

(2)数据获取方式选择:从源码中获取数据,选择提取方式“截取前后”,然后在源码中提取我们想要的信息的前后码。记住,如果它是唯一的代码,请避免提取出错。

补充:教你提取前后代码

在网页中,右击查看源代码。找到标题。我们会发现有多个重复的标题。但是要选择code前后的唯一一个,可以通过ctrl+f来验证是否唯一。下面是标题前后的代码,剩下几个元素前后的代码,大家可以自己练习。

第六步:设置存储位置

点击内容发布规则——>另存为本地文件——>启用本地文件保存——>保存设置文件格式选择txt(因为我们使用的是免费软件)——>设置保存位置

第七步:启动采集,设置存储位置和设置规则,保存退出,返回工具首页,启动采集——>这3个地方一定要勾选,然后右键选择—— >开始。见下图:

采集之后的初步数据:

呈现清洗后的数据及相关数据分析,见下图:

三、个人经验总结####

关键词文章采集源码(对于爬取翻页的流程基本如下(有些)翻页流程)

采集交流 • 优采云 发表了文章 • 0 个评论 • 463 次浏览 • 2021-08-28 20:03

给出完整代码:(需要的请自行下载,有问题请留言)

pudn下载连接:

有时间我会写一篇百度图片和谷歌图片的python爬虫博客,我会带头。

Google 图片抓取工具连接:

百度图片爬虫连接:

在此期间我正在实习。我正在做一些主要的网站 图片抓取工作。基本就告一段落了。现在搜索百度图片、谷歌图片、必应图片三张网站。抓取并下载结果。

首先通过爬取过程中遇到的问题,总结如下:

1、每次加载的图片数量每个网站都是可变的,每翻一页都会刷新。对于数据量大的爬虫,几乎都需要用到翻页功能。有以下两种方式:

1)通过网站上的网址刷新,如必应图片:

url = 'http://cn.bing.com/images/async?q={0}&first={1}&count=35&relp=35&lostate=r

&mmasync=1&dgState=x*175_y*848_h*199_c*1_i*106_r*0'

2) 使用 selenium 模拟鼠标操作来翻页,在谷歌图片抓取时会解释。

2、 每个网站 应用的图片加载技术都不同。 网站抓取静态加载的图片非常容易,因为每张图片的URL都直接显示在网页的源代码中。找到每个图片对应的url,可以使用urlretrieve()下载。但是动态加载的网站比较复杂,需要具体问题具体分析。例如,Google Pictures 每次加载 35 张图片(只能获取 35 张图片的 URL)。当滚动一次时,网页不会刷新,而是再次加载一批图片,并与之前加载的图片一起显示在网页的源代码中。对于动态加载的网站,我推荐使用selenium库来爬取。

抓取图片的过程基本如下(对于网站可以通过URL翻页或者不需要翻页):

1. 找到你需要爬取图片的网站。 (以必应为例)

2. 使用google element check(其他没用过,不再介绍)查看网页源码。

3. 使用左上角的元素检查找到图片对应的代码。

4.通过观察找到翻页的规律(有的网站动态加载是完全不可见的,不推荐这种方法)

从图中可以看到标签div,class='dgControl hover'中data-nexturl的内容会随着我们滚动页面和先翻页而不断变化,q=binary code是我们的关键词。添加前缀后,我们就得到了我们要使用的url。

5.我们把网页的源码放到BeautifulSoup中,代码如下:

url = 'http://cn.bing.com/images/async?q={0}&first={1}&count=35&relp=35&lostate=r&mmasync=1&dgState=x*175_y*848_h*199_c*1_i*106_r*0'

agent = {'User-Agent': "Mozilla/5.0 (X11; Linux x86_64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/31.0.165063 Safari/537.36 AppEngine-Google."}

page1 = urllib.request.Request(url.format(InputData, i*35+1), headers=agent)

page = urllib.request.urlopen(page1)

soup = BeautifulSoup(page.read(), 'html.parser')

我们得到的汤是一个类‘bs4.BeautifulSoup’对象,可以直接操作,具体内容可以自行搜索。

首先选择我们需要的url所在的类,如下图:

波浪线是我们需要的网址。

我们从下面的代码中得到我们需要的url:

if not os.path.exists("./" + word):#创建文件夹

os.mkdir('./' + word)

for StepOne in soup.select('.mimg'):

link=StepOne.attrs['src']#将得到的转化为字典形式并取src对应的value。

count = len(os.listdir('./' + word)) + 1

SaveImage(link,word,count)#调用函数保存得到的图片。

最后调用urlretrieve()函数下载我们得到的图片url,代码如下:

try:

time.sleep(0.2)

urllib.request.urlretrieve(link,'./'+InputData+'/'+str(count)+'.jpg')

except urllib.error.HTTPError as urllib_err:

print(urllib_err)

except Exception as err:

time.sleep(1)

print(err)

print("产生未知错误,放弃保存")

else:

print("图+1,已有" + str(count) + "张图")

这里需要强调的是,除了像之前打开的URL和当前下载的图片这样的错误检测之外,需要使用try,否则程序出现错误时很容易崩溃,极大地浪费了数据时间采集. 查看全部

关键词文章采集源码(对于爬取翻页的流程基本如下(有些)翻页流程)

给出完整代码:(需要的请自行下载,有问题请留言)

pudn下载连接:

有时间我会写一篇百度图片和谷歌图片的python爬虫博客,我会带头。

Google 图片抓取工具连接:

百度图片爬虫连接:

在此期间我正在实习。我正在做一些主要的网站 图片抓取工作。基本就告一段落了。现在搜索百度图片、谷歌图片、必应图片三张网站。抓取并下载结果。

首先通过爬取过程中遇到的问题,总结如下:

1、每次加载的图片数量每个网站都是可变的,每翻一页都会刷新。对于数据量大的爬虫,几乎都需要用到翻页功能。有以下两种方式:

1)通过网站上的网址刷新,如必应图片:

url = 'http://cn.bing.com/images/async?q={0}&first={1}&count=35&relp=35&lostate=r

&mmasync=1&dgState=x*175_y*848_h*199_c*1_i*106_r*0'

2) 使用 selenium 模拟鼠标操作来翻页,在谷歌图片抓取时会解释。

2、 每个网站 应用的图片加载技术都不同。 网站抓取静态加载的图片非常容易,因为每张图片的URL都直接显示在网页的源代码中。找到每个图片对应的url,可以使用urlretrieve()下载。但是动态加载的网站比较复杂,需要具体问题具体分析。例如,Google Pictures 每次加载 35 张图片(只能获取 35 张图片的 URL)。当滚动一次时,网页不会刷新,而是再次加载一批图片,并与之前加载的图片一起显示在网页的源代码中。对于动态加载的网站,我推荐使用selenium库来爬取。

抓取图片的过程基本如下(对于网站可以通过URL翻页或者不需要翻页):

1. 找到你需要爬取图片的网站。 (以必应为例)

2. 使用google element check(其他没用过,不再介绍)查看网页源码。

3. 使用左上角的元素检查找到图片对应的代码。

4.通过观察找到翻页的规律(有的网站动态加载是完全不可见的,不推荐这种方法)

从图中可以看到标签div,class='dgControl hover'中data-nexturl的内容会随着我们滚动页面和先翻页而不断变化,q=binary code是我们的关键词。添加前缀后,我们就得到了我们要使用的url。

5.我们把网页的源码放到BeautifulSoup中,代码如下:

url = 'http://cn.bing.com/images/async?q={0}&first={1}&count=35&relp=35&lostate=r&mmasync=1&dgState=x*175_y*848_h*199_c*1_i*106_r*0'

agent = {'User-Agent': "Mozilla/5.0 (X11; Linux x86_64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/31.0.165063 Safari/537.36 AppEngine-Google."}

page1 = urllib.request.Request(url.format(InputData, i*35+1), headers=agent)

page = urllib.request.urlopen(page1)

soup = BeautifulSoup(page.read(), 'html.parser')

我们得到的汤是一个类‘bs4.BeautifulSoup’对象,可以直接操作,具体内容可以自行搜索。

首先选择我们需要的url所在的类,如下图:

波浪线是我们需要的网址。

我们从下面的代码中得到我们需要的url:

if not os.path.exists("./" + word):#创建文件夹

os.mkdir('./' + word)

for StepOne in soup.select('.mimg'):

link=StepOne.attrs['src']#将得到的转化为字典形式并取src对应的value。

count = len(os.listdir('./' + word)) + 1

SaveImage(link,word,count)#调用函数保存得到的图片。

最后调用urlretrieve()函数下载我们得到的图片url,代码如下:

try:

time.sleep(0.2)

urllib.request.urlretrieve(link,'./'+InputData+'/'+str(count)+'.jpg')

except urllib.error.HTTPError as urllib_err:

print(urllib_err)

except Exception as err:

time.sleep(1)

print(err)

print("产生未知错误,放弃保存")

else:

print("图+1,已有" + str(count) + "张图")

这里需要强调的是,除了像之前打开的URL和当前下载的图片这样的错误检测之外,需要使用try,否则程序出现错误时很容易崩溃,极大地浪费了数据时间采集.

关键词文章采集源码(人人商城,小程序,商业源码,微信营销源码wp)

采集交流 • 优采云 发表了文章 • 0 个评论 • 153 次浏览 • 2021-09-07 03:11

2.您必须在下载后24小时内从您的电脑中彻底删除以上内容资源!

3.如果你也有好的源码或者教程,可以直接发布到会员中心。分享,购买就有收益!可以提现!

4. 本站提供的源代码、模板、插件等资源不收录技术服务。请原谅我!如果连基本的小程序都不会安装,请先在网站上购买小程序安装教程,然后再购买源代码!

5.如有链接无法下载、无效或有广告,请联系管理员QQ处理!

6.本站资源价格仅为赞助,收取的费用仅用于维持本站日常运营!

7. 本站不保证所提供下载资源的准确性、安全性和完整性,源代码仅供下载学习使用!没有人能保证程序没有bug,如果你想花几块钱来享受正版的服务!请远离本站!源代码可复现,若开启关闭退款,谢绝补贴购买!

8.如用于商业或非法用途,与本站无关,一切后果由用户负责!

9. 如果遇到加密的压缩包,默认解压密码为“”。如无法解压,请联系管理员!

动能代码站被众多网友分享:php源代码、商业源代码、wp主题、人人商店、破解模块、商业插件、微信小程序、小程序源代码、微信小程序源代码、织梦template、微信营销源码、破解软件工具等资源!

动能代码»wordpress采集resource插件:胖鼠采集 查看全部

关键词文章采集源码(人人商城,小程序,商业源码,微信营销源码wp)

2.您必须在下载后24小时内从您的电脑中彻底删除以上内容资源!

3.如果你也有好的源码或者教程,可以直接发布到会员中心。分享,购买就有收益!可以提现!

4. 本站提供的源代码、模板、插件等资源不收录技术服务。请原谅我!如果连基本的小程序都不会安装,请先在网站上购买小程序安装教程,然后再购买源代码!

5.如有链接无法下载、无效或有广告,请联系管理员QQ处理!

6.本站资源价格仅为赞助,收取的费用仅用于维持本站日常运营!

7. 本站不保证所提供下载资源的准确性、安全性和完整性,源代码仅供下载学习使用!没有人能保证程序没有bug,如果你想花几块钱来享受正版的服务!请远离本站!源代码可复现,若开启关闭退款,谢绝补贴购买!

8.如用于商业或非法用途,与本站无关,一切后果由用户负责!

9. 如果遇到加密的压缩包,默认解压密码为“”。如无法解压,请联系管理员!

动能代码站被众多网友分享:php源代码、商业源代码、wp主题、人人商店、破解模块、商业插件、微信小程序、小程序源代码、微信小程序源代码、织梦template、微信营销源码、破解软件工具等资源!