关键词文章采集源码

关键词文章采集源码(淮北seo游戏推广网站源码、采集文章(关键词))

采集交流 • 优采云 发表了文章 • 0 个评论 • 121 次浏览 • 2021-10-10 00:18

游戏推广网站源码,采集文章。淮北seo游戏推广网站源代码2、对关键词做了很好的布局,标签合理,淮北seo游戏推广网站源代码描述、标签和网站地图安排关键词。 3、不要太密集。 网站 中的 关键词 密度太高。搜索引擎认为你在作弊,你会受到惩罚。 4、关键词 密度太高,搜索引擎认为你的刻意优化会降低你的网站的权重,导致整个网站的权重下降。 关键词 的布局不宜过大。搜索引擎不喜欢太密集的东西。不仅搜索引擎会认同你,用户也会觉得无聊,所以关键词的密度一定要掌握在6-8%之间。 4、网站导航,合理使用flash、javascript等,

搜索引擎认为您的 网站 不是很友好。铜陵seo企业网站推广5、网站的内容要以网站为主题,网站的内容不能围绕关键词。 6、网站的内容应该围绕网站的核心展开。 7、合理的网站内链建设,内容要围绕网站关键词进行,内链建设也要围绕网站@的内容进行>. 8、网站内页文章,应该有相关的文章推荐,这样可以增加pv,也可以加网站pv。 9、网站的内部链构建应该在文章的内容中合理穿插网站的关键词,并穿插文章 关键词、文章穿插关键词链接到相关网页,有助于提高您的网站被搜索引擎抓取,从而提高收录@ > 您的网页。 10、淮北seo游戏推广网站源码网站内部锚文本可以强化网站的关键词,为你完善搜索引擎网站 @> 认可,淮北seo游戏推广网站源码还可以提高网站在搜索引擎中的排名, 查看全部

关键词文章采集源码(淮北seo游戏推广网站源码、采集文章(关键词))

游戏推广网站源码,采集文章。淮北seo游戏推广网站源代码2、对关键词做了很好的布局,标签合理,淮北seo游戏推广网站源代码描述、标签和网站地图安排关键词。 3、不要太密集。 网站 中的 关键词 密度太高。搜索引擎认为你在作弊,你会受到惩罚。 4、关键词 密度太高,搜索引擎认为你的刻意优化会降低你的网站的权重,导致整个网站的权重下降。 关键词 的布局不宜过大。搜索引擎不喜欢太密集的东西。不仅搜索引擎会认同你,用户也会觉得无聊,所以关键词的密度一定要掌握在6-8%之间。 4、网站导航,合理使用flash、javascript等,

搜索引擎认为您的 网站 不是很友好。铜陵seo企业网站推广5、网站的内容要以网站为主题,网站的内容不能围绕关键词。 6、网站的内容应该围绕网站的核心展开。 7、合理的网站内链建设,内容要围绕网站关键词进行,内链建设也要围绕网站@的内容进行>. 8、网站内页文章,应该有相关的文章推荐,这样可以增加pv,也可以加网站pv。 9、网站的内部链构建应该在文章的内容中合理穿插网站的关键词,并穿插文章 关键词、文章穿插关键词链接到相关网页,有助于提高您的网站被搜索引擎抓取,从而提高收录@ > 您的网页。 10、淮北seo游戏推广网站源码网站内部锚文本可以强化网站的关键词,为你完善搜索引擎网站 @> 认可,淮北seo游戏推广网站源码还可以提高网站在搜索引擎中的排名,

关键词文章采集源码(翼速基于ThinkPHP微信小程序导航公众号导航网站源码下载 )

采集交流 • 优采云 发表了文章 • 0 个评论 • 163 次浏览 • 2021-10-04 21:14

)

易速应用精品源码下载,本站提供的开源版本可以任意打开两个,仅供开发者学习。目前,微信小程序和微信公众平台仍然是非常受欢迎的程序。本模型基于ThinkPHP微信小程序导航公众号导航网站源码,主要用于分享优质微信小程序和微信公众号。可以说是一款为微信小程序和公众号快速找到一个不错的123导航系统。

前端界面非常简洁优雅,是其他劣质同类微信小程序和微信公众号导航界面无法比拟的。前端也适配了手机WAP页面。设置后台WAP域名后,会自动识别手机。终端还是PC端,界面不合理,还有文章评价系统,对小程序或公众号进行评价,达到推广效果。

后台程序主要由ThinkPHP+ACEAdmin构建,可实现小程序、公众号的一键发布和修改,具有完整强大的权限管理机制。不同的用户可以根据不同的用户组设置不同的操作权限!!!

来源说明:

1.Thinkphp3.2开发,构建需要大于5.3的php版本不加密,任何二次开发都可以。

2.访问畅言评论,后台可开启/关闭

3. 进入帖子图库的图片存储,后台有个设置开关。

4. 后台设置配置丰富,几乎不需要修改代码,全部在后台控制。

5.缓存机制可以轻松应对大流量,缓存类型可以在后台选择。

6.完善的后台管理组权限,可以为不同的管理员分配不同的操作权限

###############安装方法:###############

完整包根目录解压后,第一次打开会提示安装。安装完成后根据每一步的提示,进入后台系统设置修改你的设置。

注:手机版需要解析手机版域名,然后在系统设置-其他设置中填写手机版域名。

伪静态规则在重写目录中,根据自己的服务器设置。

默认后台账号密码admin admin123

最后清除缓存。

QQ和微博快速登录配置:后台系统设置-其他设置配置中的QQ和微博配置。(暂时只做了QQ和微博,其他第三方登录都保留了,懂代码的可以自己研究)

查看全部

关键词文章采集源码(翼速基于ThinkPHP微信小程序导航公众号导航网站源码下载

)

易速应用精品源码下载,本站提供的开源版本可以任意打开两个,仅供开发者学习。目前,微信小程序和微信公众平台仍然是非常受欢迎的程序。本模型基于ThinkPHP微信小程序导航公众号导航网站源码,主要用于分享优质微信小程序和微信公众号。可以说是一款为微信小程序和公众号快速找到一个不错的123导航系统。

前端界面非常简洁优雅,是其他劣质同类微信小程序和微信公众号导航界面无法比拟的。前端也适配了手机WAP页面。设置后台WAP域名后,会自动识别手机。终端还是PC端,界面不合理,还有文章评价系统,对小程序或公众号进行评价,达到推广效果。

后台程序主要由ThinkPHP+ACEAdmin构建,可实现小程序、公众号的一键发布和修改,具有完整强大的权限管理机制。不同的用户可以根据不同的用户组设置不同的操作权限!!!

来源说明:

1.Thinkphp3.2开发,构建需要大于5.3的php版本不加密,任何二次开发都可以。

2.访问畅言评论,后台可开启/关闭

3. 进入帖子图库的图片存储,后台有个设置开关。

4. 后台设置配置丰富,几乎不需要修改代码,全部在后台控制。

5.缓存机制可以轻松应对大流量,缓存类型可以在后台选择。

6.完善的后台管理组权限,可以为不同的管理员分配不同的操作权限

###############安装方法:###############

完整包根目录解压后,第一次打开会提示安装。安装完成后根据每一步的提示,进入后台系统设置修改你的设置。

注:手机版需要解析手机版域名,然后在系统设置-其他设置中填写手机版域名。

伪静态规则在重写目录中,根据自己的服务器设置。

默认后台账号密码admin admin123

最后清除缓存。

QQ和微博快速登录配置:后台系统设置-其他设置配置中的QQ和微博配置。(暂时只做了QQ和微博,其他第三方登录都保留了,懂代码的可以自己研究)

关键词文章采集源码(本文:网站实时数据采集系统的设计与实现1.1)

采集交流 • 优采云 发表了文章 • 0 个评论 • 133 次浏览 • 2021-10-03 18:15

【摘要】随着经济技术的进步、互联网的普及和信息高速公路的发展,社会各个角落都有大量实时变化的数据。一些实时变化的数据与人们的生活息息相关,比如股票、外汇汇率等,虽然这些数据信息可以通过网站实时观察,但数据本身是无法获取的。本文针对这个问题设计了一个网站时间序列数据采集系统。针对当前网站data采集系统的种种不足,本文详细分析了网站data采集系统的需求,并对采集系统的需求进行了深入研究。网站 数据分析与提取 在此基础上,网站 实时时间序列数据< @采集系统的设计和实现,解决了网页数据获取的盲目性和网页数据本身无法访问的问题,实现了URL的自动生成和用户定位。数据、网页数据快速采集、数据查询和变化曲线生成等重要功能。本系统的重点是建立通用的网页数据解析规则,从而能够采集网站的大部分动态数据。采用多线程技术解决了网页下载时程序界面无响应的问题,通过建立配置文件解决了系统重启时复位的问题。Unicode 程序是“utf8”。系统界面力求简洁易用。菜单栏建立,整个界面只有一个按钮,所有的设置项都是通过弹出菜单来实现的。该程序是一个在Linux系统的Qt上实现的C++项目。这是作者第一次尝试在Linux系统上编程。该系统已经通过测试,效率较高,... 【摘要】随着科技的发展,信息的高速公路,每个角落都有大量的实时数据。一些与人的生活、股票、每个角落的大量实时数据。一些与人的生活、股票、每个角落的大量实时数据。一些与人的生活、股票、 查看全部

关键词文章采集源码(本文:网站实时数据采集系统的设计与实现1.1)

【摘要】随着经济技术的进步、互联网的普及和信息高速公路的发展,社会各个角落都有大量实时变化的数据。一些实时变化的数据与人们的生活息息相关,比如股票、外汇汇率等,虽然这些数据信息可以通过网站实时观察,但数据本身是无法获取的。本文针对这个问题设计了一个网站时间序列数据采集系统。针对当前网站data采集系统的种种不足,本文详细分析了网站data采集系统的需求,并对采集系统的需求进行了深入研究。网站 数据分析与提取 在此基础上,网站 实时时间序列数据< @采集系统的设计和实现,解决了网页数据获取的盲目性和网页数据本身无法访问的问题,实现了URL的自动生成和用户定位。数据、网页数据快速采集、数据查询和变化曲线生成等重要功能。本系统的重点是建立通用的网页数据解析规则,从而能够采集网站的大部分动态数据。采用多线程技术解决了网页下载时程序界面无响应的问题,通过建立配置文件解决了系统重启时复位的问题。Unicode 程序是“utf8”。系统界面力求简洁易用。菜单栏建立,整个界面只有一个按钮,所有的设置项都是通过弹出菜单来实现的。该程序是一个在Linux系统的Qt上实现的C++项目。这是作者第一次尝试在Linux系统上编程。该系统已经通过测试,效率较高,... 【摘要】随着科技的发展,信息的高速公路,每个角落都有大量的实时数据。一些与人的生活、股票、每个角落的大量实时数据。一些与人的生活、股票、每个角落的大量实时数据。一些与人的生活、股票、

关键词文章采集源码(做小说站无话可说的好程序有哪些?(图))

采集交流 • 优采云 发表了文章 • 0 个评论 • 139 次浏览 • 2021-10-01 08:02

来源介绍

来源说明:

深度定制小说网站,全自动采集各类网站,可自动生成首页、分类、目录、排名、站点地图页面、全站拼音目录、伪静态章节页面,自动生成小说txt文件,自动生成zip压缩包。这个源码功能非常强大!带来一个非常漂亮的手机页面!带采集规则+自动适配!超级强大,采集的所有规则都可以使用,并且全自动采集和存储,非常好用,特别适合优采云维护!对于一个新颖的网站来说,一个好的程序没什么好说的。

其他特性:

(1)首页、分类、目录、排名、站点地图页(分类页、小说封面、作者页,如果html文件不存在或超过设定时间未更新,则自动生成静态html)自动更新一次,如果有采集,当采集时会自动更新小说封面和对应的分类页面),直接通过PHP调用html文件,而不是在root中生成目录,访问速度和纯静态无异,在保证源代码文件管理方便的同时可以降低服务器压力,还可以方便访问统计,增加搜索引擎识别度。

(2)全站拼音编目,章节页面伪静态。

(3)小说txt文件自动生成,也可以后台重新生成txt文件。

(4)自动生成小说关键词和关键词自动内链。

(5)自动伪原创单词替换(采集时替换)。

(6)新增小说总点击量、月点击量、周点击量、总推荐量、月度推荐量、周推荐统计、作者推荐统计等功能。

(7)配合CNZZ的统计插件,方便实现小说下载量和藏书量的详细统计。

(8)本程序的自动采集不是市面上常见的优采云、广管、采集等,而是原有的采集功能DEDE基于采集模块二次开发,可有效保证章节内容的完整性,避免章节重复、章节内容无内容、章节乱码等;采集可达25~每天 24 小时 30 万个章节。

安装注意事项:

1、上传到网站的根目录

2、使用phpMyadmin导入数据库文件xiaoshuo.sql

3、修改数据库链接文件/data/common.inc.php

(切记不要用记事本修改,否则可能会出现验证码无法显示的问题,建议使用记事本++)

4、后台目录/admin/index.php

帐号管理员密码管理员

免责声明:本站尊重所有网络文件的版权问题。所有软件文件均来自网络。所有提供下载的软件和资源均由软件或程序作者提供,并由网友推荐。它们仅用于学习和研究。如果您侵犯了您的版权,请发邮件至邮箱:,本站将立即更正。本站绝对支持网络版权。

立即编辑终身VIP 查看全部

关键词文章采集源码(做小说站无话可说的好程序有哪些?(图))

来源介绍

来源说明:

深度定制小说网站,全自动采集各类网站,可自动生成首页、分类、目录、排名、站点地图页面、全站拼音目录、伪静态章节页面,自动生成小说txt文件,自动生成zip压缩包。这个源码功能非常强大!带来一个非常漂亮的手机页面!带采集规则+自动适配!超级强大,采集的所有规则都可以使用,并且全自动采集和存储,非常好用,特别适合优采云维护!对于一个新颖的网站来说,一个好的程序没什么好说的。

其他特性:

(1)首页、分类、目录、排名、站点地图页(分类页、小说封面、作者页,如果html文件不存在或超过设定时间未更新,则自动生成静态html)自动更新一次,如果有采集,当采集时会自动更新小说封面和对应的分类页面),直接通过PHP调用html文件,而不是在root中生成目录,访问速度和纯静态无异,在保证源代码文件管理方便的同时可以降低服务器压力,还可以方便访问统计,增加搜索引擎识别度。

(2)全站拼音编目,章节页面伪静态。

(3)小说txt文件自动生成,也可以后台重新生成txt文件。

(4)自动生成小说关键词和关键词自动内链。

(5)自动伪原创单词替换(采集时替换)。

(6)新增小说总点击量、月点击量、周点击量、总推荐量、月度推荐量、周推荐统计、作者推荐统计等功能。

(7)配合CNZZ的统计插件,方便实现小说下载量和藏书量的详细统计。

(8)本程序的自动采集不是市面上常见的优采云、广管、采集等,而是原有的采集功能DEDE基于采集模块二次开发,可有效保证章节内容的完整性,避免章节重复、章节内容无内容、章节乱码等;采集可达25~每天 24 小时 30 万个章节。

安装注意事项:

1、上传到网站的根目录

2、使用phpMyadmin导入数据库文件xiaoshuo.sql

3、修改数据库链接文件/data/common.inc.php

(切记不要用记事本修改,否则可能会出现验证码无法显示的问题,建议使用记事本++)

4、后台目录/admin/index.php

帐号管理员密码管理员

免责声明:本站尊重所有网络文件的版权问题。所有软件文件均来自网络。所有提供下载的软件和资源均由软件或程序作者提供,并由网友推荐。它们仅用于学习和研究。如果您侵犯了您的版权,请发邮件至邮箱:,本站将立即更正。本站绝对支持网络版权。

立即编辑终身VIP

关键词文章采集源码(运行环境nt/2003orFramework1.12000开发环境VS2003)

采集交流 • 优采云 发表了文章 • 0 个评论 • 95 次浏览 • 2021-09-28 17:20

看预览图: 运行环境 windows nt/xp/2003 or Framework 1.1SqlServer 2000 开发环境 VS 2003 目的 学习网络编程后,总有事可做。于是我想到了做一个网页内容采集器。作者主页:使用方法 测试数据来自cnBlog。如下图所示,用户首先填写“起始页”,即从哪个页面开始采集。然后填写数据库连接字符串,这里是采集的数据插入的数据库定义,然后选择表名,不用说了。网页编码,如果不出意外,中国大陆可以用UTF-8来抓取文件名正则:呵呵,这个工具显然是给程序员用的。您必须直接填写常规规则。例如,cnblogs都是数字,所以写\d来建表帮助:用户指定创建几个varchar类型,几个text类型,主要放短数据和长数据。如果您的表中已经有列,请避免使用它们。程序中没有验证。在网页设置中:采集标签前后的内容:比如有xxx,如果我要采集xxx,就写“to”,当然就是to之间的内容. 接下来的几个文本框用于显示内容。点击“获取网址”,查看它抓取的网址是否正确。点击“采集”将采集的内容放入数据库,然后使用Insert xx()(选择xx)直接插入目标数据。程序代码量很小(而且很简陋),需要做一些改动。缺点应用于正则表达式和网络编程,因为它们是最简单的东西,所以没有使用多线程,没有其他优化方法,也不支持分页。我测试了一下,得到了38条数据,使用了700M内存。. . . 如果你有用,你可以改变它。方便程序员使用,无需编写大量代码。Surance Yin@ Surance Center 转载请注明出处 查看全部

关键词文章采集源码(运行环境nt/2003orFramework1.12000开发环境VS2003)

看预览图: 运行环境 windows nt/xp/2003 or Framework 1.1SqlServer 2000 开发环境 VS 2003 目的 学习网络编程后,总有事可做。于是我想到了做一个网页内容采集器。作者主页:使用方法 测试数据来自cnBlog。如下图所示,用户首先填写“起始页”,即从哪个页面开始采集。然后填写数据库连接字符串,这里是采集的数据插入的数据库定义,然后选择表名,不用说了。网页编码,如果不出意外,中国大陆可以用UTF-8来抓取文件名正则:呵呵,这个工具显然是给程序员用的。您必须直接填写常规规则。例如,cnblogs都是数字,所以写\d来建表帮助:用户指定创建几个varchar类型,几个text类型,主要放短数据和长数据。如果您的表中已经有列,请避免使用它们。程序中没有验证。在网页设置中:采集标签前后的内容:比如有xxx,如果我要采集xxx,就写“to”,当然就是to之间的内容. 接下来的几个文本框用于显示内容。点击“获取网址”,查看它抓取的网址是否正确。点击“采集”将采集的内容放入数据库,然后使用Insert xx()(选择xx)直接插入目标数据。程序代码量很小(而且很简陋),需要做一些改动。缺点应用于正则表达式和网络编程,因为它们是最简单的东西,所以没有使用多线程,没有其他优化方法,也不支持分页。我测试了一下,得到了38条数据,使用了700M内存。. . . 如果你有用,你可以改变它。方便程序员使用,无需编写大量代码。Surance Yin@ Surance Center 转载请注明出处

关键词文章采集源码(素材代下载搜索引擎系统/自带/源码素材付费下载系统)

采集交流 • 优采云 发表了文章 • 0 个评论 • 174 次浏览 • 2021-09-28 16:40

源代码名称:

素材下载搜索引擎系统/自带/源码付费下载系统/全站打包完善运行版源码下载

来源说明:

材料代下的行业在互联网上也有点历史。这几年前图网、牛图网、窝图网生成的网站图片素材更是牛逼,好玩的模板源码网也买了。法,这代的源码有点不一样,是源码下载源码网的源码,所以比较新,从500朋友那里买的。

程序原创开发,支付对接轻松支付,代码支付,全站数据和域名出售,百度搜狗关键词:源码生成,生成源码,都在首页

缺点:此用户登录必须连接QQ上网登录,有能力的可以自己注册登录

1、采用了新的php+mysql框架,特征码没有被百度抓取,所以收录的效果和权重提升的效果就不讨论了。

2、mysql数据库,自己导入关键词,自己行业导入即可

3、 聚焦并推送自己的行业词汇,避免收录无关的关键词

4、整体UI界面优化更简洁,用户进来也不会觉得是垃圾站

5、合理的SEO优化结构,病毒式传播,组合,让蜘蛛自由爬行收录

6、 无壳,无蜘蛛池,无需租二级目录,只是一个旧域名

7、突破百度冰桶算法5.0

8、是目前最有效、最稳定、最简单、最划算、排名第一的程序

源代码截图:

[相关下载] 会员免费下载。非会员可单独购买

点击下载 查看全部

关键词文章采集源码(素材代下载搜索引擎系统/自带/源码素材付费下载系统)

源代码名称:

素材下载搜索引擎系统/自带/源码付费下载系统/全站打包完善运行版源码下载

来源说明:

材料代下的行业在互联网上也有点历史。这几年前图网、牛图网、窝图网生成的网站图片素材更是牛逼,好玩的模板源码网也买了。法,这代的源码有点不一样,是源码下载源码网的源码,所以比较新,从500朋友那里买的。

程序原创开发,支付对接轻松支付,代码支付,全站数据和域名出售,百度搜狗关键词:源码生成,生成源码,都在首页

缺点:此用户登录必须连接QQ上网登录,有能力的可以自己注册登录

1、采用了新的php+mysql框架,特征码没有被百度抓取,所以收录的效果和权重提升的效果就不讨论了。

2、mysql数据库,自己导入关键词,自己行业导入即可

3、 聚焦并推送自己的行业词汇,避免收录无关的关键词

4、整体UI界面优化更简洁,用户进来也不会觉得是垃圾站

5、合理的SEO优化结构,病毒式传播,组合,让蜘蛛自由爬行收录

6、 无壳,无蜘蛛池,无需租二级目录,只是一个旧域名

7、突破百度冰桶算法5.0

8、是目前最有效、最稳定、最简单、最划算、排名第一的程序

源代码截图:

[相关下载] 会员免费下载。非会员可单独购买

点击下载

关键词文章采集源码(2021年新版PTCMS小说精美多风格四套全新版本在线听书带下载插件)

采集交流 • 优采云 发表了文章 • 0 个评论 • 179 次浏览 • 2021-09-27 17:10

2021年PTcms小说新版精美多风格四套新版在线听书带下载插件.zip

2021年PTcms小说新版精美多风格。新版四套是带下载插件的在线听书。给大家介绍一下PTcms的教程。功能介绍:新开发,新版UI,增加原创专区,新闻发布,书单发布,采集日志,百度推送,神马推送,推送日志功能。前端高仿起点小说网,自适应模板,可分手机域名。后端是用LAYUI新开发的。以下是设置内容: 一、 服务器环境需要推荐的linux环境,win也支持,不过我没有测试设置,按照下面的教程自己测试。以下是我搭建nginx的环境1. 15 MySQL 5.5 php7.3 install php extension fileinfo memcached swoole4 在php7.3二、configure Swoole1、的disable函数中删除shell exec /www/在server/文件中创建ptcms文件夹,将license和loader73.so上传到ptcms,2、打开php的配置文件7.3(并调用php.ini)拉到底,添加以下两行代码,保存,重启php,如果报错,检查以上步骤有没有错误!extension=/www/server/ptcms/loader73.so swoole_license_files=/www/server/ptcms/license三、配置网站设置,< @1、点击网站——点击站点名称或设置2、设置网站运行目录为public<

下面说一下配置cron启动主进程。启动方式是1、 首先,我们可以使用SHH链接工具,或者直接连接宝塔的SHH连接。2、 进入shh连接页面,需要登录连接服务器输入以下代码,进入网站目录,看我截图cd/www/wwwroot/网站 root目录名然后输入以下代码启动主进程任务,我已经启动了这个,所以很正常。一开始看起来像下图 /www/server/php/73/bin/phpkxcron:check 现在我们回到后台刷新页面,可以再次看到流程采集,点击自动开启刷新,会自动刷新页面,基本的安装和设置都到这里了,现在来说说列表< @采集设置分页和后台设置分页采集。分页规则应由 [page] 设置。设置列表时,选择前台或后台离线。前台浏览器不能关闭,浏览器和电脑都可以关闭。起始页可以从任何页面开始,前提是目标站点有此页,结束页相同,且必须等于或大于起始页。设置后台任务页面采集 点击任务进入下一页。附加参数:"start/*/end/#" *和#分别填写起始采集页码和结束采集页码对应位置;对应规则,参数填写为“开始/开始页码/结束/结束页码”,

现在就下载 查看全部

关键词文章采集源码(2021年新版PTCMS小说精美多风格四套全新版本在线听书带下载插件)

2021年PTcms小说新版精美多风格四套新版在线听书带下载插件.zip

2021年PTcms小说新版精美多风格。新版四套是带下载插件的在线听书。给大家介绍一下PTcms的教程。功能介绍:新开发,新版UI,增加原创专区,新闻发布,书单发布,采集日志,百度推送,神马推送,推送日志功能。前端高仿起点小说网,自适应模板,可分手机域名。后端是用LAYUI新开发的。以下是设置内容: 一、 服务器环境需要推荐的linux环境,win也支持,不过我没有测试设置,按照下面的教程自己测试。以下是我搭建nginx的环境1. 15 MySQL 5.5 php7.3 install php extension fileinfo memcached swoole4 在php7.3二、configure Swoole1、的disable函数中删除shell exec /www/在server/文件中创建ptcms文件夹,将license和loader73.so上传到ptcms,2、打开php的配置文件7.3(并调用php.ini)拉到底,添加以下两行代码,保存,重启php,如果报错,检查以上步骤有没有错误!extension=/www/server/ptcms/loader73.so swoole_license_files=/www/server/ptcms/license三、配置网站设置,< @1、点击网站——点击站点名称或设置2、设置网站运行目录为public<

下面说一下配置cron启动主进程。启动方式是1、 首先,我们可以使用SHH链接工具,或者直接连接宝塔的SHH连接。2、 进入shh连接页面,需要登录连接服务器输入以下代码,进入网站目录,看我截图cd/www/wwwroot/网站 root目录名然后输入以下代码启动主进程任务,我已经启动了这个,所以很正常。一开始看起来像下图 /www/server/php/73/bin/phpkxcron:check 现在我们回到后台刷新页面,可以再次看到流程采集,点击自动开启刷新,会自动刷新页面,基本的安装和设置都到这里了,现在来说说列表< @采集设置分页和后台设置分页采集。分页规则应由 [page] 设置。设置列表时,选择前台或后台离线。前台浏览器不能关闭,浏览器和电脑都可以关闭。起始页可以从任何页面开始,前提是目标站点有此页,结束页相同,且必须等于或大于起始页。设置后台任务页面采集 点击任务进入下一页。附加参数:"start/*/end/#" *和#分别填写起始采集页码和结束采集页码对应位置;对应规则,参数填写为“开始/开始页码/结束/结束页码”,

现在就下载

关键词文章采集源码(如何应对网络中的新闻内容也一样?系统帮你解决)

采集交流 • 优采云 发表了文章 • 0 个评论 • 124 次浏览 • 2021-09-27 17:07

随着互联网的飞速发展,互联网极大地提高了信息生成和传播的速度。互联网上每天都会产生大量的内容。如何从这些杂乱无章的内容中高效地发现和采集需要的信息似乎越来越多。越重要。互联网上的新闻内容也是如此。新闻分布在不同的网站上,存在重复的内容。我们往往只关心一些新闻。互联网上的新闻页面往往充斥着大量与新闻无关的新闻页面。这些信息会影响我们的阅读效率和阅读体验。如何更方便、及时、高效地获取我们关心的新闻内容,这个系统可以帮我们做到这一点。本系统利用网络爬虫对互联网上的新闻进行定时、有针对性的分析和采集,然后对采集接收到的数据进行去重、分类和存储。进入数据库,最终提供个性化的新闻订阅服务。考虑如何处理网站的反爬虫策略,避免被网站拦截。在具体的实现中,会使用Python和scrapy等框架来编写爬虫,使用特定的内容提取算法来提取目标数据。最后使用Django和weui提供新闻订阅后台和新闻内容展示页面,使用微信向用户推送信息。用户可以通过本系统订阅指定关键词,

[关键词] 网络爬虫;消息; 个性化;订阅; Python

参考文档及完整文档及源代码下载地址: 查看全部

关键词文章采集源码(如何应对网络中的新闻内容也一样?系统帮你解决)

随着互联网的飞速发展,互联网极大地提高了信息生成和传播的速度。互联网上每天都会产生大量的内容。如何从这些杂乱无章的内容中高效地发现和采集需要的信息似乎越来越多。越重要。互联网上的新闻内容也是如此。新闻分布在不同的网站上,存在重复的内容。我们往往只关心一些新闻。互联网上的新闻页面往往充斥着大量与新闻无关的新闻页面。这些信息会影响我们的阅读效率和阅读体验。如何更方便、及时、高效地获取我们关心的新闻内容,这个系统可以帮我们做到这一点。本系统利用网络爬虫对互联网上的新闻进行定时、有针对性的分析和采集,然后对采集接收到的数据进行去重、分类和存储。进入数据库,最终提供个性化的新闻订阅服务。考虑如何处理网站的反爬虫策略,避免被网站拦截。在具体的实现中,会使用Python和scrapy等框架来编写爬虫,使用特定的内容提取算法来提取目标数据。最后使用Django和weui提供新闻订阅后台和新闻内容展示页面,使用微信向用户推送信息。用户可以通过本系统订阅指定关键词,

[关键词] 网络爬虫;消息; 个性化;订阅; Python

参考文档及完整文档及源代码下载地址:

关键词文章采集源码(2017年10月29日更新如下:插件实现的功能)

采集交流 • 优采云 发表了文章 • 0 个评论 • 129 次浏览 • 2021-09-27 13:18

安装此PHPcms模块后,采集器控制面板将出现在版本的顶部文章。在发布编辑框中输入关键词或网站智能采集内容。它具有易学、易懂、易用、成熟、稳定的特点。它是PHPcms新手站长和网站编辑必备的模块

插件实现的功能如下:

1、最新最热门的微信官方账号文章采集每天都会自动更新。p>

2、最新最热门的信息采集,每天自动更新

3、输入关键词,采集与关键词相关的最新内容

4、输入内容页面的URL和此页面的内容

5、支持云通用伪原创

6、支持采集优酷视频、腾讯视频和56视频

7、支持微信公众号视频采集

8、支持特殊的垂直方向采集

如笑话、图片、视频、微信公众号等

9、支持自动内容布局

10、支持批量采集和批量发布

11、支持三种编辑器:fck、CK和UE

2017年10月29日更新如下:

1、根据关键词采集

2、您可以定制伪原创同义词表,以实现采集和收录的双赢局面

3、新的实时采集、批量采集、网站采集等

软件名称:

中大运采集PHPcmsV版9.0

软件语言:

简体中文

源代码大小:

842 KB

操作平台:

PHP/Mysql

软件许可:

免费版江苏电信下载内蒙古网通下载 查看全部

关键词文章采集源码(2017年10月29日更新如下:插件实现的功能)

安装此PHPcms模块后,采集器控制面板将出现在版本的顶部文章。在发布编辑框中输入关键词或网站智能采集内容。它具有易学、易懂、易用、成熟、稳定的特点。它是PHPcms新手站长和网站编辑必备的模块

插件实现的功能如下:

1、最新最热门的微信官方账号文章采集每天都会自动更新。p>

2、最新最热门的信息采集,每天自动更新

3、输入关键词,采集与关键词相关的最新内容

4、输入内容页面的URL和此页面的内容

5、支持云通用伪原创

6、支持采集优酷视频、腾讯视频和56视频

7、支持微信公众号视频采集

8、支持特殊的垂直方向采集

如笑话、图片、视频、微信公众号等

9、支持自动内容布局

10、支持批量采集和批量发布

11、支持三种编辑器:fck、CK和UE

2017年10月29日更新如下:

1、根据关键词采集

2、您可以定制伪原创同义词表,以实现采集和收录的双赢局面

3、新的实时采集、批量采集、网站采集等

软件名称:

中大运采集PHPcmsV版9.0

软件语言:

简体中文

源代码大小:

842 KB

操作平台:

PHP/Mysql

软件许可:

免费版江苏电信下载内蒙古网通下载

关键词文章采集源码(一个跟踪关键字资讯收集的程序--一个之Spider)

采集交流 • 优采云 发表了文章 • 0 个评论 • 126 次浏览 • 2021-09-27 10:16

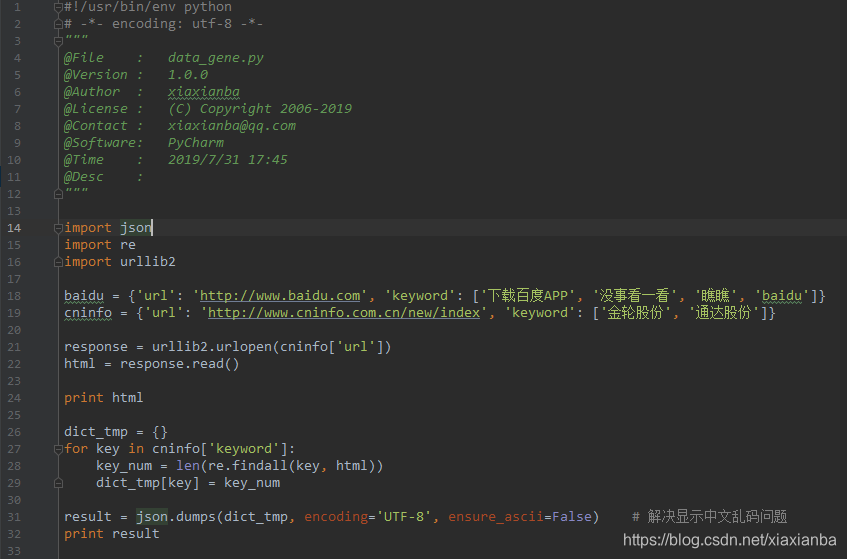

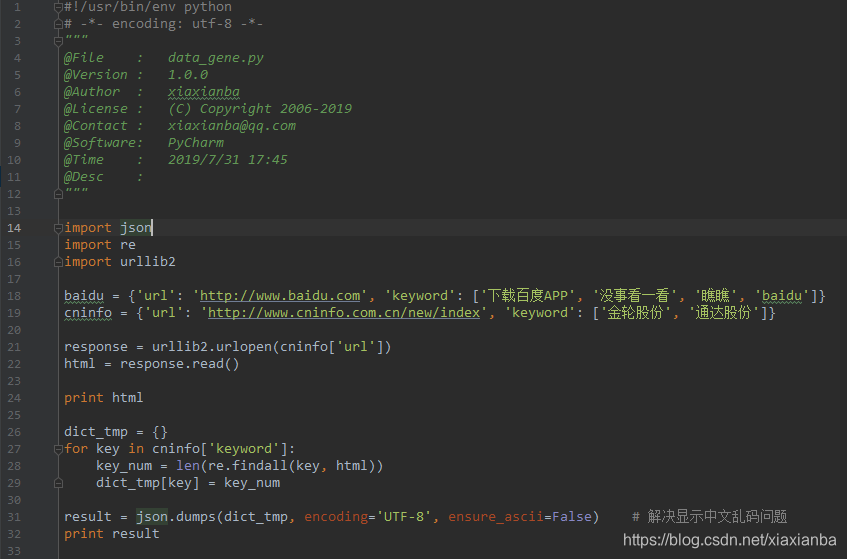

投资者都知道,早、晚、晚有很多信息需要关注,包括政府政策(国务院、央行、证监会、统计局)、新闻披露(交易所、新闻更新) 、公司公告、门户网站)。网站)、财务审计(财报公告、审计机构)等。随着研究的深入,信息量越来越大,每天花在这上面的时间会越来越多,就像无底洞一样投资不一定有收益,但不投资的风险太大。任何异常事件都会造成致命的损失。基于此,作者开发了一个程序来跟踪关键字信息的采集。

一、思考

作者的灵感来源是百度搜索。其实我们每天都可以得到百度搜索关键词的信息,只是来源太杂乱。当然,通过过滤URL可以找到真实的信息,但是时间成本太高,而且还存在抓取不及时、信息不全等现象,参考以下案例:

site:: 限制搜索范围,只搜索

“中国平安”:完全匹配,只查找收录“中国平安”完整字段的内容

借鉴百度搜索的思路,作者直接通过python从需要关注的网页中抓取网页内容,通过网页内容找到关键词,解决了上述关键词关注的问题。因此,作者使用统计关键词来达到查看网站相关信息的目的,从而节省时间。以下是作者的实现代码:

二、有一些问题网站。我们看到的内容和我们通过“查看网页源代码”的方式看到的内容是不一样的。它们之间可能有一个跳转过程。这时,通过程序计算的统计结果会与实际结果有所不同。(如果有解决方法的读者朋友看到,请联系作者)

参考

1.Github 之蜘蛛源代码 查看全部

关键词文章采集源码(一个跟踪关键字资讯收集的程序--一个之Spider)

投资者都知道,早、晚、晚有很多信息需要关注,包括政府政策(国务院、央行、证监会、统计局)、新闻披露(交易所、新闻更新) 、公司公告、门户网站)。网站)、财务审计(财报公告、审计机构)等。随着研究的深入,信息量越来越大,每天花在这上面的时间会越来越多,就像无底洞一样投资不一定有收益,但不投资的风险太大。任何异常事件都会造成致命的损失。基于此,作者开发了一个程序来跟踪关键字信息的采集。

一、思考

作者的灵感来源是百度搜索。其实我们每天都可以得到百度搜索关键词的信息,只是来源太杂乱。当然,通过过滤URL可以找到真实的信息,但是时间成本太高,而且还存在抓取不及时、信息不全等现象,参考以下案例:

site:: 限制搜索范围,只搜索

“中国平安”:完全匹配,只查找收录“中国平安”完整字段的内容

借鉴百度搜索的思路,作者直接通过python从需要关注的网页中抓取网页内容,通过网页内容找到关键词,解决了上述关键词关注的问题。因此,作者使用统计关键词来达到查看网站相关信息的目的,从而节省时间。以下是作者的实现代码:

二、有一些问题网站。我们看到的内容和我们通过“查看网页源代码”的方式看到的内容是不一样的。它们之间可能有一个跳转过程。这时,通过程序计算的统计结果会与实际结果有所不同。(如果有解决方法的读者朋友看到,请联系作者)

参考

1.Github 之蜘蛛源代码

关键词文章采集源码(聊城市东昌府区太之*信息科技**ST88会员优化关键词)

采集交流 • 优采云 发表了文章 • 0 个评论 • 121 次浏览 • 2021-09-25 01:08

聊城市东昌府区太直

**:太智* 服务区域:全国推广范围:全国

我公司业务:百度招投标、百度优化、百度爱采购、百度爱采购招标、百度下拉框、MWordba画面、制作网站、优化关键词、B2B网站平台会员一代Open、B2B网站发帖软件、小程序开发、百度搜索下拉框、百度竞价包月、MWordba屏、迅瓜瓜等。

您可以使用发帖软件,但您不会使用其他软件。由于该软件具有欺骗性,您可能会在购买后打开该软件。

您可以先注册**使用本软件,您可以使用并适应这种发帖方式后才能申请软件会员

因此您在使用该软件时不会承担任何风险

黄页88 会员代理开通优化关键词 虽然网上有类似勤发发软件的工具,但发布数量有限,只有一个。网站,操作步骤麻烦,收费高

内容:发布的内容也很重要。我们建议: ①不要抄袭内容,即使是抄袭,也尽量抄袭你的官方网站。抄袭别人,一定要改一些,抄袭很难搜索引擎收录;②? 内容应尽可能丰富。所谓丰富不是堆积无用的文字,而应该与标题有关。是便于客户阅读的分层内容;③? 文字要自然出现 关键词 ,不要堆砌关键词,在文中留下联系方式,如,,网址等4.域名whois同域名,有一定没有不良历史记录,比如你之前的网站如果你曾经K过,或者做过非法网站,注册新域名时尽量不要使用自己的个人域名。大量非法站点使用更便宜的域名,成本相对较低。搜索引擎将使用这些域名。网站 被视为非法站点。如果我们使用这样的域名,就相当于进入了搜索引擎的黑名单。

<p>黄页88会员优化关键词3、网站结构**网站结构也会影响网站2、放弃网站的排名@> 在一定程度上。@采集文章现在搜索引擎一直在强调网站的用户体验,一个网站如果有很多 查看全部

关键词文章采集源码(聊城市东昌府区太之*信息科技**ST88会员优化关键词)

聊城市东昌府区太直

**:太智* 服务区域:全国推广范围:全国

我公司业务:百度招投标、百度优化、百度爱采购、百度爱采购招标、百度下拉框、MWordba画面、制作网站、优化关键词、B2B网站平台会员一代Open、B2B网站发帖软件、小程序开发、百度搜索下拉框、百度竞价包月、MWordba屏、迅瓜瓜等。

您可以使用发帖软件,但您不会使用其他软件。由于该软件具有欺骗性,您可能会在购买后打开该软件。

您可以先注册**使用本软件,您可以使用并适应这种发帖方式后才能申请软件会员

因此您在使用该软件时不会承担任何风险

黄页88 会员代理开通优化关键词 虽然网上有类似勤发发软件的工具,但发布数量有限,只有一个。网站,操作步骤麻烦,收费高

内容:发布的内容也很重要。我们建议: ①不要抄袭内容,即使是抄袭,也尽量抄袭你的官方网站。抄袭别人,一定要改一些,抄袭很难搜索引擎收录;②? 内容应尽可能丰富。所谓丰富不是堆积无用的文字,而应该与标题有关。是便于客户阅读的分层内容;③? 文字要自然出现 关键词 ,不要堆砌关键词,在文中留下联系方式,如,,网址等4.域名whois同域名,有一定没有不良历史记录,比如你之前的网站如果你曾经K过,或者做过非法网站,注册新域名时尽量不要使用自己的个人域名。大量非法站点使用更便宜的域名,成本相对较低。搜索引擎将使用这些域名。网站 被视为非法站点。如果我们使用这样的域名,就相当于进入了搜索引擎的黑名单。

<p>黄页88会员优化关键词3、网站结构**网站结构也会影响网站2、放弃网站的排名@> 在一定程度上。@采集文章现在搜索引擎一直在强调网站的用户体验,一个网站如果有很多

关键词文章采集源码(l3232nzx如何确保服务器稳定工作?(图))

采集交流 • 优采云 发表了文章 • 0 个评论 • 246 次浏览 • 2021-09-22 08:23

吉林关键词采集外部设备 - 行业经验丰富L32NZX

确保服务器稳定。服务器的稳定性不仅与用户体验问题有关,而且对捕获也有很大的影响。 SEO应检查服务器状态,查看网站日志,检查是否有500个状态代码或其他标记,并找到隐藏危险的存在。

SEO的主要工作是通过了解各种搜索引擎如何捕获Internet页面,如何索引,以及如何确定其技术,如搜索结果的特定关键词等。它改善了搜索引擎排名,从而增加网站 @访问,*结束增强网站的销售能力或促销能力技术。吉林关键词采集外包服务。

季度网站更新:通常@ @ @ @ @ @ @ @ @ @提期会,距,因此*初始高级排名只有一半的成功,搜索引擎是不断变化的算法。自然搜索引擎优化和营销目标全部更新每个季度客户网站,并不断更改搜索引擎的显示。这些更新将通过搜索引擎的算法促进额外的产品关键字。搜索引擎优化不仅仅是结果,而且是一个连续的过程。

百度节拍屏幕是A *常规SEO操作方法,它是SEO的*思维,其本质是:使用高强有力的第三方平台做你想要的是关键词因为第三方平台的高重量可以快速获得排名,导致姜黄和排水的影响。当然,潘站群,黑人站点有很多技术,并跳进百度暴君,但这些技术适用于短暂的项目,不适合企业站。吉林关键词采集外包服务。

防止标题重复:在页面的结构中,您应该注意不使用重复的标题。这也将使用户没有真诚,确保每个页面具有相对独立的分页,防止重复性内容,它可以显示更好的想法和规范,允许用户达到网页图像的新高度。

百度将排序信息。所有来百度搜索的人,他们想快速找到自己的答案,百度也了解客户的想法,所以他们开发了一套计划,排序所有这些抢手的信息,然后把他相信好的答案在前面排名并为客户提供。

网站也与seo服务相同,也是网站的重量,除了指定的查找引擎@ @ @ @ @ @ @ @ @ @ @ @ @ @ @ @ @ @ @ @ @ @ @ @ @ @ @ @ @ @ @ @ @ @ managersy over网络营销实现人们估计没有人不知道SEO,即寻找发动机优化,这是一种在搜索搜索引擎排名中寻找搜索引擎的方法。吉林关键词采集外包服务。

网站 ranking迅速:有一定的营销技术和网络体验,您可以让网站在数千次竞争中网站,发现潜在客户所需的信息*时间。产品信息涵盖所有主要网络:公共信息,产品信息在主要网络中发布,允许业务信息涵盖大型网络。

写一个文章:太短文章 @ @ @ @ @ @ @ @ 爱站不不,一般操纵每个文章至少300字。另一方面,不要让文章似乎太长,因为这不会有利于重要词语的密度,文章似乎是紧凑的。讨论显示太长文章将迅速减少读者的数量,他们选择关闭文章。

事实上,许多人正在讨论SEO和SEM之间的关系。在我看来,SEO和SEM是一种不干涉的关系,但也相互影响。两种方式都可以单独运行,但一旦SEO运行,效果会好得多,SEO基本上是收录,有收录有排名,将有流量,流量,流量,流量,流量, 查看全部

关键词文章采集源码(l3232nzx如何确保服务器稳定工作?(图))

吉林关键词采集外部设备 - 行业经验丰富L32NZX

确保服务器稳定。服务器的稳定性不仅与用户体验问题有关,而且对捕获也有很大的影响。 SEO应检查服务器状态,查看网站日志,检查是否有500个状态代码或其他标记,并找到隐藏危险的存在。

SEO的主要工作是通过了解各种搜索引擎如何捕获Internet页面,如何索引,以及如何确定其技术,如搜索结果的特定关键词等。它改善了搜索引擎排名,从而增加网站 @访问,*结束增强网站的销售能力或促销能力技术。吉林关键词采集外包服务。

季度网站更新:通常@ @ @ @ @ @ @ @ @ @提期会,距,因此*初始高级排名只有一半的成功,搜索引擎是不断变化的算法。自然搜索引擎优化和营销目标全部更新每个季度客户网站,并不断更改搜索引擎的显示。这些更新将通过搜索引擎的算法促进额外的产品关键字。搜索引擎优化不仅仅是结果,而且是一个连续的过程。

百度节拍屏幕是A *常规SEO操作方法,它是SEO的*思维,其本质是:使用高强有力的第三方平台做你想要的是关键词因为第三方平台的高重量可以快速获得排名,导致姜黄和排水的影响。当然,潘站群,黑人站点有很多技术,并跳进百度暴君,但这些技术适用于短暂的项目,不适合企业站。吉林关键词采集外包服务。

防止标题重复:在页面的结构中,您应该注意不使用重复的标题。这也将使用户没有真诚,确保每个页面具有相对独立的分页,防止重复性内容,它可以显示更好的想法和规范,允许用户达到网页图像的新高度。

百度将排序信息。所有来百度搜索的人,他们想快速找到自己的答案,百度也了解客户的想法,所以他们开发了一套计划,排序所有这些抢手的信息,然后把他相信好的答案在前面排名并为客户提供。

网站也与seo服务相同,也是网站的重量,除了指定的查找引擎@ @ @ @ @ @ @ @ @ @ @ @ @ @ @ @ @ @ @ @ @ @ @ @ @ @ @ @ @ @ @ @ @ @ managersy over网络营销实现人们估计没有人不知道SEO,即寻找发动机优化,这是一种在搜索搜索引擎排名中寻找搜索引擎的方法。吉林关键词采集外包服务。

网站 ranking迅速:有一定的营销技术和网络体验,您可以让网站在数千次竞争中网站,发现潜在客户所需的信息*时间。产品信息涵盖所有主要网络:公共信息,产品信息在主要网络中发布,允许业务信息涵盖大型网络。

写一个文章:太短文章 @ @ @ @ @ @ @ @ 爱站不不,一般操纵每个文章至少300字。另一方面,不要让文章似乎太长,因为这不会有利于重要词语的密度,文章似乎是紧凑的。讨论显示太长文章将迅速减少读者的数量,他们选择关闭文章。

事实上,许多人正在讨论SEO和SEM之间的关系。在我看来,SEO和SEM是一种不干涉的关系,但也相互影响。两种方式都可以单独运行,但一旦SEO运行,效果会好得多,SEO基本上是收录,有收录有排名,将有流量,流量,流量,流量,流量,

关键词文章采集源码(:关键词文章采集源码及配置采集前的准备)

采集交流 • 优采云 发表了文章 • 0 个评论 • 140 次浏览 • 2021-09-19 20:04

关键词文章采集源码及配置采集前准备我们需要在写博客的时候准备好我们需要采集的文章列表,比如:找死的python与sqlmap之间的对比。针对采集某一数据源、某一文章进行采集。因为我们是自己写的采集,所以我们先需要搞定这两点。准备好我们采集的源码。编写文章采集的代码文章采集一般是带有tags标签的,tags我们可以在页面上获取到,也可以通过xpath获取到。

我们将这篇文章里的内容tags命名为“user-agent”。打开mysql的select查询,查看row返回值的值和data值。根据我们刚才获取到的返回值,我们发现。所有字段值都是我们自己定义的,与采集其他字段没有任何关系。这种情况下,我们需要建立一个表,然后定义所有字段的关系。我们首先通过db_create建立一个表,然后再打开windows数据库,运行mysqldump命令查看sqlmap的数据。

这里我们打开的是表datetable_title,这里我们可以看到,所有数据都是定义好的,没有任何关系。我们来看看表title字段,默认使用了一个sqlite格式的字段,我们定义datastring="useragent"获取这个字段。因为我们要获取tags下的所有文章,所以我们需要传入一个row字段,然后传入数据。

我们新建了两个字段表datestring和datestring_array。分别使用“”表示列名。那么问题来了,在建立表和索引时,为什么只能存在一个字段?难道“*”不行吗?其实,当有多个字段时,我们需要复制字段名,再建立表和索引。我们新建mysqldump,然后运行mysqlinsert,会出现log信息,然后打开db_create.sqlmap命令,查看row返回值和data值。

如果报错了,也是因为这两个字段我们定义的name没有对应上。我们还是需要传入row字段。windows数据库打开mysqldb_create.sqlmap命令。我们首先查看mysqldump命令的输出,发现数据是file是datestring_array。但是我们不希望它输出数据,我们希望它输出tags下所有文章的信息。

我们需要把datestring_array传给mysqldb_create.sqlmap命令。mysqldb_create.sqlmap命令打开mysqldb,mysqldb_create.sqlmap命令是打开一个mysql数据库,并且还不能修改数据库。因为打开的文件不能修改。我们只能编辑文件。编辑mysqldb_create.sqlmap命令:1.我们选择第一个参数表示目标库(dbname),如下:1table_id=tab_id2tab_url='/root/data:/tabs/data/'3create_table_name=user-agent4mysql_db_info={'table_id':2,'tab_url':'/','tab_name':"。 查看全部

关键词文章采集源码(:关键词文章采集源码及配置采集前的准备)

关键词文章采集源码及配置采集前准备我们需要在写博客的时候准备好我们需要采集的文章列表,比如:找死的python与sqlmap之间的对比。针对采集某一数据源、某一文章进行采集。因为我们是自己写的采集,所以我们先需要搞定这两点。准备好我们采集的源码。编写文章采集的代码文章采集一般是带有tags标签的,tags我们可以在页面上获取到,也可以通过xpath获取到。

我们将这篇文章里的内容tags命名为“user-agent”。打开mysql的select查询,查看row返回值的值和data值。根据我们刚才获取到的返回值,我们发现。所有字段值都是我们自己定义的,与采集其他字段没有任何关系。这种情况下,我们需要建立一个表,然后定义所有字段的关系。我们首先通过db_create建立一个表,然后再打开windows数据库,运行mysqldump命令查看sqlmap的数据。

这里我们打开的是表datetable_title,这里我们可以看到,所有数据都是定义好的,没有任何关系。我们来看看表title字段,默认使用了一个sqlite格式的字段,我们定义datastring="useragent"获取这个字段。因为我们要获取tags下的所有文章,所以我们需要传入一个row字段,然后传入数据。

我们新建了两个字段表datestring和datestring_array。分别使用“”表示列名。那么问题来了,在建立表和索引时,为什么只能存在一个字段?难道“*”不行吗?其实,当有多个字段时,我们需要复制字段名,再建立表和索引。我们新建mysqldump,然后运行mysqlinsert,会出现log信息,然后打开db_create.sqlmap命令,查看row返回值和data值。

如果报错了,也是因为这两个字段我们定义的name没有对应上。我们还是需要传入row字段。windows数据库打开mysqldb_create.sqlmap命令。我们首先查看mysqldump命令的输出,发现数据是file是datestring_array。但是我们不希望它输出数据,我们希望它输出tags下所有文章的信息。

我们需要把datestring_array传给mysqldb_create.sqlmap命令。mysqldb_create.sqlmap命令打开mysqldb,mysqldb_create.sqlmap命令是打开一个mysql数据库,并且还不能修改数据库。因为打开的文件不能修改。我们只能编辑文件。编辑mysqldb_create.sqlmap命令:1.我们选择第一个参数表示目标库(dbname),如下:1table_id=tab_id2tab_url='/root/data:/tabs/data/'3create_table_name=user-agent4mysql_db_info={'table_id':2,'tab_url':'/','tab_name':"。

关键词文章采集源码(一篇文章可以优化几百关键词吗?当然可以吗)

采集交流 • 优采云 发表了文章 • 0 个评论 • 135 次浏览 • 2021-09-19 13:08

许多SEOER每天都写原创但他们的个人能力有限。他们一天不能输出很多文章。相反,那些采集伪原创的排名每天都在提高。一个文章能优化数百个关键词吗?当然今天,error blog()共享的内容是“如何使用一个文章优化数百个关键词”。我希望它能帮助你

一、关键词和网站与页面之间的关系

每个网站在不主宰屏幕的情况下,关键词理论上只在一个页面上优化,更多将导致站内竞争。想要在同一个网站的同一个关键词主屏幕上获得多个更好的排名并不容易

理论上,一个关键词只在一个页面上排列,但一个页面上可以优化多个关键词。从网站主页可以看出,大多数网站主页都有很高的权重,可以优化很多关键词

所以我们经常看到网站主页上有很多关键词的排名,排名也很好

但是如果你想用一个文章来优化多个关键词可以吗?当然可以,但是文章页面的关键词排名相对不稳定。它不如主页、专栏、主题甚至标签页好,因为它们属于文章list。此外,文章本身的权重也不太适合优化。一些文章在类似的网站中确实有很多关键词排名,但它们属于高质量电台中的少数精品店文章

二、an-article原创optimization-100关键词

上述概念基本上是指一个文章页面来优化多个关键词,而错误博客文章是关于一个原创文章来优化多个关键词@

因为一个原创文章可以修改关键词来创建多个文章,理论上,只要操作正确,这样的页面也符合搜索引擎规范。当然,有些人可能会以这种方式作弊

优化原创文章中数百个关键词的方法非常简单,即文章文章中关键词的密度非常高,只要修改这个关键词,就可以直接影响文章的相似性,得到的文章与原创相似@

当一篇高质量的原创文章文章收录大量文章和不同的关键词在同一天制作,并且所有这些页面同时提交给搜索引擎时,搜索引擎很可能会判断原创并且即使感觉到文章重复,概率也会是收录的一部分

当然,这出戏的前提是网站确实有一定程度的搜索引擎友好性,可以达到收录周或收录次日,甚至可以达到收录和收录秒。在收录大多数人都有排名后,他们可以使用这种操作方法。对于一些本身并不收录的网站,所有技能都是免费的

上面是错误博客()共享的内容是“如何用一个文章优化数百个关键词”。谢谢你的阅读。更多原创文章搜索“错误日志” 查看全部

关键词文章采集源码(一篇文章可以优化几百关键词吗?当然可以吗)

许多SEOER每天都写原创但他们的个人能力有限。他们一天不能输出很多文章。相反,那些采集伪原创的排名每天都在提高。一个文章能优化数百个关键词吗?当然今天,error blog()共享的内容是“如何使用一个文章优化数百个关键词”。我希望它能帮助你

一、关键词和网站与页面之间的关系

每个网站在不主宰屏幕的情况下,关键词理论上只在一个页面上优化,更多将导致站内竞争。想要在同一个网站的同一个关键词主屏幕上获得多个更好的排名并不容易

理论上,一个关键词只在一个页面上排列,但一个页面上可以优化多个关键词。从网站主页可以看出,大多数网站主页都有很高的权重,可以优化很多关键词

所以我们经常看到网站主页上有很多关键词的排名,排名也很好

但是如果你想用一个文章来优化多个关键词可以吗?当然可以,但是文章页面的关键词排名相对不稳定。它不如主页、专栏、主题甚至标签页好,因为它们属于文章list。此外,文章本身的权重也不太适合优化。一些文章在类似的网站中确实有很多关键词排名,但它们属于高质量电台中的少数精品店文章

二、an-article原创optimization-100关键词

上述概念基本上是指一个文章页面来优化多个关键词,而错误博客文章是关于一个原创文章来优化多个关键词@

因为一个原创文章可以修改关键词来创建多个文章,理论上,只要操作正确,这样的页面也符合搜索引擎规范。当然,有些人可能会以这种方式作弊

优化原创文章中数百个关键词的方法非常简单,即文章文章中关键词的密度非常高,只要修改这个关键词,就可以直接影响文章的相似性,得到的文章与原创相似@

当一篇高质量的原创文章文章收录大量文章和不同的关键词在同一天制作,并且所有这些页面同时提交给搜索引擎时,搜索引擎很可能会判断原创并且即使感觉到文章重复,概率也会是收录的一部分

当然,这出戏的前提是网站确实有一定程度的搜索引擎友好性,可以达到收录周或收录次日,甚至可以达到收录和收录秒。在收录大多数人都有排名后,他们可以使用这种操作方法。对于一些本身并不收录的网站,所有技能都是免费的

上面是错误博客()共享的内容是“如何用一个文章优化数百个关键词”。谢谢你的阅读。更多原创文章搜索“错误日志”

关键词文章采集源码(数据集、实现代码介绍:候选词生成(下))

采集交流 • 优采云 发表了文章 • 0 个评论 • 121 次浏览 • 2021-09-19 03:06

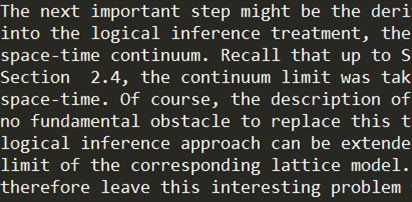

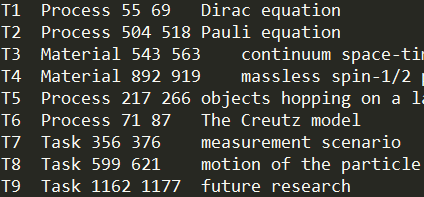

目录:第1部分:概述第2部分:数据集和实现代码简介第3部分:特征设计第4部分:候选词生成(I)第5部分:候选词生成(II)第6部分:性能比较

这个博客将介绍我的关键词提取系统使用的数据集和我实现的代码结构。如果读者想在阅读博客时查看数据并运行代码,这将是一个很好的指南

2.1数据集简介

本文中用于培训和测试的数据来自semeval 2017任务10。有500篇论文来自计算机科学、材料科学和物理学领域,每一篇都收录选定的段落和关键词注释信息。其中350个用作训练集,其余150个用作测试集。每篇论文的选定段落约为200字的纯文本,不包括标题和摘要等结构信息。对测试集进行简单的统计,每张试卷都标有关键词约20。可以看出,该数据集具有以下特点:文本长度较短,但标签数关键词远高于正常值,这有利于机器学习取得更好的效果。这里有两个文本截图和相应的关键词标签,可以获得直观的感觉

您可以从semeval 2017任务10的官方网站获取有关数据集的更多信息

2.2实现代码介绍

我的系统分两步实现关键词提取。Mr.首先形成候选词,然后使用分类模型在候选词上选择关键词。在候选词生成阶段,我们使用了两种方法,名词短语提取和CRF注释,并在第六章中比较了它们的性能

这里的代码SRC是在Python3中使用nltk、sklearn和其他库实现的。一些数据不包括在内,例如单词向量和训练数据

代码的内容和每个文件的含义描述如下:

根目录:

--Main.py运行文件

--Ekrsy/code文件夹

----init.py

----py实现文档和关键字类

----Feature.py实现各种功能来提取特征

----Util.py封装了一些工具和方法

----py封装了从文件中读取字向量的功能

----Test.py一些测试方法

----Log.py定义日志格式

----crf_u工具.py实现了crf++注释的数据转换,并调用模型进行注释

----py实现了提取候选词的功能

----py实现各种分类模型

----py封装文档集类

--数据/放置所使用的数据文件

----训练/训练数据集

----开发/测试数据集

----使用CRF+的CRF/CRF注释配置文件+

----外部资源/外部资源数据

------freq Wikipedia计算的英语文章词频

------IDF Wikipedia计算的反向文档频率

------IEEE文本分类表

------Glove.6b.50d.txt手套训练字向量数据

本系列文章将不介绍具体的代码细节,如果需要运行结果,代码应该很容易理解

本文文章介绍了关键词提取系统的数据集和实现代码结构。接下来,将介绍特征设计和候选词生成 查看全部

关键词文章采集源码(数据集、实现代码介绍:候选词生成(下))

目录:第1部分:概述第2部分:数据集和实现代码简介第3部分:特征设计第4部分:候选词生成(I)第5部分:候选词生成(II)第6部分:性能比较

这个博客将介绍我的关键词提取系统使用的数据集和我实现的代码结构。如果读者想在阅读博客时查看数据并运行代码,这将是一个很好的指南

2.1数据集简介

本文中用于培训和测试的数据来自semeval 2017任务10。有500篇论文来自计算机科学、材料科学和物理学领域,每一篇都收录选定的段落和关键词注释信息。其中350个用作训练集,其余150个用作测试集。每篇论文的选定段落约为200字的纯文本,不包括标题和摘要等结构信息。对测试集进行简单的统计,每张试卷都标有关键词约20。可以看出,该数据集具有以下特点:文本长度较短,但标签数关键词远高于正常值,这有利于机器学习取得更好的效果。这里有两个文本截图和相应的关键词标签,可以获得直观的感觉

您可以从semeval 2017任务10的官方网站获取有关数据集的更多信息

2.2实现代码介绍

我的系统分两步实现关键词提取。Mr.首先形成候选词,然后使用分类模型在候选词上选择关键词。在候选词生成阶段,我们使用了两种方法,名词短语提取和CRF注释,并在第六章中比较了它们的性能

这里的代码SRC是在Python3中使用nltk、sklearn和其他库实现的。一些数据不包括在内,例如单词向量和训练数据

代码的内容和每个文件的含义描述如下:

根目录:

--Main.py运行文件

--Ekrsy/code文件夹

----init.py

----py实现文档和关键字类

----Feature.py实现各种功能来提取特征

----Util.py封装了一些工具和方法

----py封装了从文件中读取字向量的功能

----Test.py一些测试方法

----Log.py定义日志格式

----crf_u工具.py实现了crf++注释的数据转换,并调用模型进行注释

----py实现了提取候选词的功能

----py实现各种分类模型

----py封装文档集类

--数据/放置所使用的数据文件

----训练/训练数据集

----开发/测试数据集

----使用CRF+的CRF/CRF注释配置文件+

----外部资源/外部资源数据

------freq Wikipedia计算的英语文章词频

------IDF Wikipedia计算的反向文档频率

------IEEE文本分类表

------Glove.6b.50d.txt手套训练字向量数据

本系列文章将不介绍具体的代码细节,如果需要运行结果,代码应该很容易理解

本文文章介绍了关键词提取系统的数据集和实现代码结构。接下来,将介绍特征设计和候选词生成

关键词文章采集源码(如何应对网络中的新闻内容也一样?系统帮你解决)

采集交流 • 优采云 发表了文章 • 0 个评论 • 97 次浏览 • 2021-09-16 20:11

随着互联网的飞速发展,互联网极大地提高了信息的生成和传播速度。每天网络上都会产生大量的内容。如何有效地从这些无序的内容中发现和采集需要的信息变得越来越重要。网络上的新闻内容也是如此。新闻在不同的网站上发布,内容重复。我们通常只关心一些新闻。网络上的新闻页面往往充斥着大量与新闻无关的信息,这影响了我们的阅读效率和阅读体验,如何更方便、及时、高效地获取我们所关注的新闻内容,本系统可以帮助我们做到这一点。通过网络爬虫,我们可以定期、定向地对网络上的采集新闻网站进行分析和采集处理,然后经过重复数据消除、分类等操作,将采集数据存储在数据库中,最终提供个性化的新闻订阅服务。考虑如何处理网站反爬虫策略,以避免被网站爬虫阻塞。在具体实现中,将使用python配合sketch等框架编写爬虫程序,并使用特定的内容提取算法提取目标数据。最后,Django和weui将用于提供新闻订阅背景和新闻内容显示页面,微信将用于向用户推送信息。用户可以通过系统订阅指定的关键字。当爬虫系统抓取收录指定关键字的内容时,它会将新闻推送给用户

[关键词]网络爬虫;新闻业;个性化;订阅蟒蛇

参考文档和完整文档及源代码下载地址: 查看全部

关键词文章采集源码(如何应对网络中的新闻内容也一样?系统帮你解决)

随着互联网的飞速发展,互联网极大地提高了信息的生成和传播速度。每天网络上都会产生大量的内容。如何有效地从这些无序的内容中发现和采集需要的信息变得越来越重要。网络上的新闻内容也是如此。新闻在不同的网站上发布,内容重复。我们通常只关心一些新闻。网络上的新闻页面往往充斥着大量与新闻无关的信息,这影响了我们的阅读效率和阅读体验,如何更方便、及时、高效地获取我们所关注的新闻内容,本系统可以帮助我们做到这一点。通过网络爬虫,我们可以定期、定向地对网络上的采集新闻网站进行分析和采集处理,然后经过重复数据消除、分类等操作,将采集数据存储在数据库中,最终提供个性化的新闻订阅服务。考虑如何处理网站反爬虫策略,以避免被网站爬虫阻塞。在具体实现中,将使用python配合sketch等框架编写爬虫程序,并使用特定的内容提取算法提取目标数据。最后,Django和weui将用于提供新闻订阅背景和新闻内容显示页面,微信将用于向用户推送信息。用户可以通过系统订阅指定的关键字。当爬虫系统抓取收录指定关键字的内容时,它会将新闻推送给用户

[关键词]网络爬虫;新闻业;个性化;订阅蟒蛇

参考文档和完整文档及源代码下载地址:

关键词文章采集源码(如何应对网络上的新闻网站的反爬虫策略(图))

采集交流 • 优采云 发表了文章 • 0 个评论 • 138 次浏览 • 2021-09-16 20:08

随着互联网的飞速发展,互联网极大地提高了信息的生成和传播速度。每天网络上都会产生大量的内容。如何有效地从这些无序的内容中发现和采集需要的信息变得越来越重要。网络上的新闻内容是一样的。新闻在不同的网站上发布,内容重复。我们通常只关心一些新闻。网络上的新闻页面往往充斥着大量与新闻无关的信息,这影响了我们的阅读效率和阅读体验,如何更方便、及时、高效地获取我们所关注的新闻内容,本系统可以帮助我们做到这一点。通过网络爬虫,我们可以对网络上的采集新闻网站进行定期、定向的分析和采集处理,经过重复数据消除、分类等操作后将采集数据存储在数据库中,最终提供个性化的新闻订阅服务。考虑如何处理网站的反爬行策略,以避免被网站爬行器阻塞。在具体实现中,将使用python配合sketch等框架编写爬虫程序,并使用特定的内容提取算法提取目标数据。最后,Django和weui将用于提供新闻订阅背景和新闻内容显示页面,微信将用于向用户推送信息。用户可以通过系统订阅指定的关键字。当爬虫系统抓取收录指定关键字的内容时,它会将新闻推送给用户

[关键词]网络爬虫;新闻业;个性化;订阅蟒蛇

参考文档和完整文档及源代码下载地址: 查看全部

关键词文章采集源码(如何应对网络上的新闻网站的反爬虫策略(图))

随着互联网的飞速发展,互联网极大地提高了信息的生成和传播速度。每天网络上都会产生大量的内容。如何有效地从这些无序的内容中发现和采集需要的信息变得越来越重要。网络上的新闻内容是一样的。新闻在不同的网站上发布,内容重复。我们通常只关心一些新闻。网络上的新闻页面往往充斥着大量与新闻无关的信息,这影响了我们的阅读效率和阅读体验,如何更方便、及时、高效地获取我们所关注的新闻内容,本系统可以帮助我们做到这一点。通过网络爬虫,我们可以对网络上的采集新闻网站进行定期、定向的分析和采集处理,经过重复数据消除、分类等操作后将采集数据存储在数据库中,最终提供个性化的新闻订阅服务。考虑如何处理网站的反爬行策略,以避免被网站爬行器阻塞。在具体实现中,将使用python配合sketch等框架编写爬虫程序,并使用特定的内容提取算法提取目标数据。最后,Django和weui将用于提供新闻订阅背景和新闻内容显示页面,微信将用于向用户推送信息。用户可以通过系统订阅指定的关键字。当爬虫系统抓取收录指定关键字的内容时,它会将新闻推送给用户

[关键词]网络爬虫;新闻业;个性化;订阅蟒蛇

参考文档和完整文档及源代码下载地址:

关键词文章采集源码(Vue-beta.0vue源码注释:文章中源码的语法都使用Flow)

采集交流 • 优采云 发表了文章 • 0 个评论 • 220 次浏览 • 2021-09-15 15:23

Vue是中国全球三分之一的前端网络终端。作为我的主要技术之一,我了解它,并对日常使用感到好奇。因此,此外,最近社区中出现了大量读取文章的Vue源代码。借此机会,我从大家的文章和讨论中汲取了一些营养,并在阅读源代码时总结了一些想法,制作了一些文章,作为我思想的总结,我的水平有限,欢迎留言讨论~

目标Vue版本:2.5.17-beta.0

Vue源代码注释:

语句:文章使用flow作为源代码的语法,并根据需要对源代码进行了删节(以避免混淆)。如果要查看完整版本,请在上面输入GitHub地址。本文是一系列文章,底部显示了文章地址~

1.响应系统

通过官网的介绍,我们知道vue.js是一个MVVM框架。它不关心视图更改,而是通过数据驱动的视图更新,这使得我们的状态管理非常简单,这是如何实现的。从官方网站偷一张照片

每个组件实例都有一个对应的观察者实例对象。它将在组件渲染期间将属性记录为依赖项。稍后,当调用依赖项的setter时,它将通知观察者重新计算,以便更新其关联的组件

有三个重要的概念:observe、DEP和watcher,分别位于Src/core/observer/index.js、Src/core/observer/DEP.js和Src/core/observer/monitor.js中

2.代码实现2.1初始状态

响应条目位于Src/core/instance/init.js的initstate中:

// src/core/instance/state.js

export function initState(vm: Component) {

const opts = vm.$options

if (opts.props) initProps(vm, opts.props) // 初始化props

if (opts.methods) initMethods(vm, opts.methods) // 初始化methods

if (opts.data) initData(vm) // 初始化data

if (opts.computed) initComputed(vm, opts.computed) // 初始化computed

if (opts.watch) initWatch(vm, opts.watch) // 初始化watch

}

}

它定期定义几种方法来初始化道具、方法、数据、计算和wathcer。让我们看一下iITDATA方法

// src/core/instance/state.js

function initData(vm: Component) {

let data = vm.$options.data

data = vm._data = typeof data === 'function'

? getData(data, vm)

: data || {}

observe(data, true /* asRootData */) // 给data做响应式处理

}

首先,判断下一个数据是否是函数,如果是则取返回值,如果不是则取自身。然后采用观察法对数据进行处理。此方法尝试为_uu uuu创建观察者实例,如果成功创建,将返回一个新的观察者实例。如果存在现有的观察者实例,则返回现有的观察者实例

2.2观察员/定义活动

// src/core/observer/index.js

export function observe (value: any, asRootData: ?boolean): Observer | void {

let ob: Observer | void

ob = new Observer(value)

return ob

}

此方法主要使用数据作为参数来实例化观察者对象实例。Observer是一个用于依赖项采集和通知更新的类。观察者构造函数使用definereactive方法形式化对象的键响应,递归地向对象的属性添加getter/setter,在获取数据时触发getter并采集依赖项,在修改值时,首先触发getter,然后触发setter并发送更新

// src/core/observer/index.js

export class Observer {

value: any;

dep: Dep;

constructor (value: any) {

value: any;

this.dep = new Dep()

def(value, '__ob__', this) // def方法保证不可枚举

this.walk(value)

}

// 遍历对象的每一个属性并将它们转换为getter/setter

walk (obj: Object) {

const keys = Object.keys(obj)

for (let i = 0; i < keys.length; i++) { // 把所有可遍历的对象响应式化

defineReactive(obj, keys[i])

}

}

}

export function defineReactive ( obj: Object, key: string, val: any, customSetter?: ?Function, shallow?: boolean) {

const dep = new Dep() // 在每个响应式键值的闭包中定义一个dep对象

// 如果之前该对象已经预设了getter/setter则将其缓存,新定义的getter/setter中会将其执行

const getter = property && property.get

const setter = property && property.set

let childOb = !shallow && observe(val)

Object.defineProperty(obj, key, {

enumerable: true,

configurable: true,

get: function reactiveGetter () {

const value = getter ? getter.call(obj) : val // 如果原本对象拥有getter方法则执行

if (Dep.target) { // 如果当前有watcher在读取当前值

dep.depend() // 那么进行依赖收集,dep.addSub

}

return value

},

set: function reactiveSetter (newVal) {

const value = getter ? getter.call(obj) : val // 先getter

if (newVal === value || (newVal !== newVal && value !== value)) { // 如果跟原来值一样则不管

return

}

if (setter) { setter.call(obj, newVal) } // 如果原本对象拥有setter方法则执行

else { val = newVal }

dep.notify() // 如果发生变更,则通知更新,调用watcher.update()

}

})

}

依赖项采集在getter期间执行。请注意,依赖项采集仅在dep.target中有值时执行。调用watcher实例的get方法时,pushtarget将此dep.target推入dep.target,原创watcher推入targetstack,获取watcher的当前值后,将其移出堆栈,并将原创watcher值分配给dep.target。Cleanupdeps将最终清除不再在新Dept中的观察程序,以防止视图中触发不必要的无用观察程序

设置setter时,首先获取getter,如果与旧值相比没有变化,则返回。如果有更改,DEP将通知SUB中存储的所有依赖于此数据的观察者实例进行更新。这里,queuewatcher()将异步推送到dispatcher observer队列。下一步执行时,flushschedulerqueue()取出队列中的观察程序,执行watcher.run并执行相关的钩子函数

2.3副署长

上面多次提到了关键词dep。它是依赖项集合的容器,或称为依赖项采集器。它记录哪些观察者依赖于他们自己的更改,或者哪些观察者订阅他们自己的更改;以下是一位网友的一句话:

@刘宏义0101:简单来说就是引用和计数。我会记下借我钱的人。当我的钱少的时候,我会告诉他们我没有钱

记录借贷者的小账簿是这里dep实例中的子账簿

// src/core/observer/dep.js

let uid = 0 // Dep实例的id,为了方便去重

export default class Dep {

static target: ?Watcher // 当前是谁在进行依赖的收集

id: number

subs: Array // 观察者集合

constructor() {

this.id = uid++ // Dep实例的id,为了方便去重

this.subs = [] // 存储收集器中需要通知的Watcher

}

addSub(sub: Watcher) { ... } /* 添加一个观察者对象 */

removeSub(sub: Watcher) { ... } /* 移除一个观察者对象 */

depend() { ... } /* 依赖收集,当存在Dep.target的时候把自己添加观察者的依赖中 */

notify() { ... } /* 通知所有订阅者 */

}

const targetStack = [] // watcher栈

export function pushTarget(_target: ?Watcher) { ... } /* 将watcher观察者实例设置给Dep.target,用以依赖收集。同时将该实例存入target栈中 */

export function popTarget() { ... } /* 将观察者实例从target栈中取出并设置给Dep.target */

这里,dep实例中SUB采集的依赖关系是watcher,它是watcher的一个实例,将来将用于通知更新

2.4观察者

// src/core/observer/watcher.js

/* 一个解析表达式,进行依赖收集的观察者,同时在表达式数据变更时触发回调函数。它被用于$watch api以及指令 */

export default class Watcher {

constructor(

vm: Component,

expOrFn: string | Function,

cb: Function,

options?: ?Object,

isRenderWatcher?: boolean // 是否是渲染watcher的标志位

) {

this.getter = expOrFn // 在get方法中执行

if (this.computed) { // 是否是 计算属性

this.value = undefined

this.dep = new Dep() // 计算属性创建过程中并未求值

} else { // 不是计算属性会立刻求值

this.value = this.get()

}

}

/* 获得getter的值并且重新进行依赖收集 */

get() {

pushTarget(this) // 设置Dep.target = this

let value

value = this.getter.call(vm, vm)

popTarget() // 将观察者实例从target栈中取出并设置给Dep.target

this.cleanupDeps()

return value

}

addDep(dep: Dep) { ... } /* 添加一个依赖关系到Deps集合中 */

cleanupDeps() { ... } /* 清理newDeps里没有的无用watcher依赖 */

update() { ... } /* 调度者接口,当依赖发生改变的时候进行回调 */

run() { ... } /* 调度者工作接口,将被调度者回调 */

getAndInvoke(cb: Function) { ... }

evaluate() { ... } /* 收集该watcher的所有deps依赖 */

depend() { ... } /* 收集该watcher的所有deps依赖,只有计算属性使用 */

teardown() { ... } /* 将自身从所有依赖收集订阅列表删除 */

}

get方法中执行的getter是updatecomponent=()=>;{VM._update(VM._render(),hydrating)},此方法从VM_render()开始生成渲染的vnode树。在此过程中,它访问当前Vue实例的VM上的数据,触发相应响应对象的getter,然后VM_uuUpdate()进行修补

注意,这里的get方法最终执行getandinvoke。此方法首先遍历存储在watcher中的DEP,删除不再在newdep中的订阅,然后depids=newdepids;DEPs=newdeps,清除newdepid和newdeps。每次添加新订阅时,不再需要的旧订阅都将被删除,以便在某些情况下,例如,当依赖于模板的数据发生变化时,V-IF不再需要该模板,观察者将不会收到更新通知

2.5总结

整个采集过程都与此有关。您可以将其与上述过程进行比较

观察者可在以下情况下使用:

只要它依赖于其他观察者,比如数据、数据属性、计算属性和道具,那么在闭包中就会生成一个dep实例dep,dep.dependent将在调用getter时采集依赖它的人,并将依赖的观察者存储在它自己的子中,即this.sub.push(sub),以便在更改时通知将其存储在dep.subs数组中。如果依赖它的观察者发生变化,请及时更新~

只要对象依赖于其他响应对象,就会生成一个观察者观察者来计算观察者依赖于哪些响应对象。在评估观察程序之前,将当前观察程序设置为全局dep.target,并在从属响应对象发生变化时及时更新它

本文是一个系列文章,稍后将进行更新以共同取得进展~

Vue源代码读取-文件结构和操作机制Vue源代码读取-依赖项采集原则Vue源代码读取-批量异步更新和nexttick原则

互联网上的大多数帖子深度不同,甚至相互矛盾。接下来的文章是学习过程的总结。如果您发现错误,欢迎您留言并指出~

参考:

Vue2.1.7源代码学习vue.js技术秘密分析vue.js内部运行机制vue.js文档【大干货】携手带您通过vue部分源代码学习vue.js源代码学习I-数据选项状态学习 查看全部

关键词文章采集源码(Vue-beta.0vue源码注释:文章中源码的语法都使用Flow)

Vue是中国全球三分之一的前端网络终端。作为我的主要技术之一,我了解它,并对日常使用感到好奇。因此,此外,最近社区中出现了大量读取文章的Vue源代码。借此机会,我从大家的文章和讨论中汲取了一些营养,并在阅读源代码时总结了一些想法,制作了一些文章,作为我思想的总结,我的水平有限,欢迎留言讨论~

目标Vue版本:2.5.17-beta.0

Vue源代码注释:

语句:文章使用flow作为源代码的语法,并根据需要对源代码进行了删节(以避免混淆)。如果要查看完整版本,请在上面输入GitHub地址。本文是一系列文章,底部显示了文章地址~

1.响应系统

通过官网的介绍,我们知道vue.js是一个MVVM框架。它不关心视图更改,而是通过数据驱动的视图更新,这使得我们的状态管理非常简单,这是如何实现的。从官方网站偷一张照片

每个组件实例都有一个对应的观察者实例对象。它将在组件渲染期间将属性记录为依赖项。稍后,当调用依赖项的setter时,它将通知观察者重新计算,以便更新其关联的组件

有三个重要的概念:observe、DEP和watcher,分别位于Src/core/observer/index.js、Src/core/observer/DEP.js和Src/core/observer/monitor.js中

2.代码实现2.1初始状态

响应条目位于Src/core/instance/init.js的initstate中:

// src/core/instance/state.js

export function initState(vm: Component) {

const opts = vm.$options

if (opts.props) initProps(vm, opts.props) // 初始化props

if (opts.methods) initMethods(vm, opts.methods) // 初始化methods

if (opts.data) initData(vm) // 初始化data

if (opts.computed) initComputed(vm, opts.computed) // 初始化computed

if (opts.watch) initWatch(vm, opts.watch) // 初始化watch

}

}

它定期定义几种方法来初始化道具、方法、数据、计算和wathcer。让我们看一下iITDATA方法

// src/core/instance/state.js

function initData(vm: Component) {

let data = vm.$options.data

data = vm._data = typeof data === 'function'

? getData(data, vm)

: data || {}

observe(data, true /* asRootData */) // 给data做响应式处理

}

首先,判断下一个数据是否是函数,如果是则取返回值,如果不是则取自身。然后采用观察法对数据进行处理。此方法尝试为_uu uuu创建观察者实例,如果成功创建,将返回一个新的观察者实例。如果存在现有的观察者实例,则返回现有的观察者实例

2.2观察员/定义活动

// src/core/observer/index.js

export function observe (value: any, asRootData: ?boolean): Observer | void {

let ob: Observer | void

ob = new Observer(value)

return ob

}

此方法主要使用数据作为参数来实例化观察者对象实例。Observer是一个用于依赖项采集和通知更新的类。观察者构造函数使用definereactive方法形式化对象的键响应,递归地向对象的属性添加getter/setter,在获取数据时触发getter并采集依赖项,在修改值时,首先触发getter,然后触发setter并发送更新

// src/core/observer/index.js

export class Observer {

value: any;

dep: Dep;

constructor (value: any) {

value: any;

this.dep = new Dep()

def(value, '__ob__', this) // def方法保证不可枚举

this.walk(value)

}

// 遍历对象的每一个属性并将它们转换为getter/setter

walk (obj: Object) {

const keys = Object.keys(obj)

for (let i = 0; i < keys.length; i++) { // 把所有可遍历的对象响应式化

defineReactive(obj, keys[i])

}

}

}

export function defineReactive ( obj: Object, key: string, val: any, customSetter?: ?Function, shallow?: boolean) {

const dep = new Dep() // 在每个响应式键值的闭包中定义一个dep对象

// 如果之前该对象已经预设了getter/setter则将其缓存,新定义的getter/setter中会将其执行

const getter = property && property.get

const setter = property && property.set

let childOb = !shallow && observe(val)

Object.defineProperty(obj, key, {

enumerable: true,

configurable: true,

get: function reactiveGetter () {

const value = getter ? getter.call(obj) : val // 如果原本对象拥有getter方法则执行

if (Dep.target) { // 如果当前有watcher在读取当前值

dep.depend() // 那么进行依赖收集,dep.addSub

}

return value

},

set: function reactiveSetter (newVal) {

const value = getter ? getter.call(obj) : val // 先getter

if (newVal === value || (newVal !== newVal && value !== value)) { // 如果跟原来值一样则不管

return

}

if (setter) { setter.call(obj, newVal) } // 如果原本对象拥有setter方法则执行

else { val = newVal }

dep.notify() // 如果发生变更,则通知更新,调用watcher.update()

}

})

}

依赖项采集在getter期间执行。请注意,依赖项采集仅在dep.target中有值时执行。调用watcher实例的get方法时,pushtarget将此dep.target推入dep.target,原创watcher推入targetstack,获取watcher的当前值后,将其移出堆栈,并将原创watcher值分配给dep.target。Cleanupdeps将最终清除不再在新Dept中的观察程序,以防止视图中触发不必要的无用观察程序

设置setter时,首先获取getter,如果与旧值相比没有变化,则返回。如果有更改,DEP将通知SUB中存储的所有依赖于此数据的观察者实例进行更新。这里,queuewatcher()将异步推送到dispatcher observer队列。下一步执行时,flushschedulerqueue()取出队列中的观察程序,执行watcher.run并执行相关的钩子函数

2.3副署长

上面多次提到了关键词dep。它是依赖项集合的容器,或称为依赖项采集器。它记录哪些观察者依赖于他们自己的更改,或者哪些观察者订阅他们自己的更改;以下是一位网友的一句话:

@刘宏义0101:简单来说就是引用和计数。我会记下借我钱的人。当我的钱少的时候,我会告诉他们我没有钱

记录借贷者的小账簿是这里dep实例中的子账簿

// src/core/observer/dep.js

let uid = 0 // Dep实例的id,为了方便去重

export default class Dep {

static target: ?Watcher // 当前是谁在进行依赖的收集

id: number

subs: Array // 观察者集合

constructor() {

this.id = uid++ // Dep实例的id,为了方便去重

this.subs = [] // 存储收集器中需要通知的Watcher

}

addSub(sub: Watcher) { ... } /* 添加一个观察者对象 */

removeSub(sub: Watcher) { ... } /* 移除一个观察者对象 */

depend() { ... } /* 依赖收集,当存在Dep.target的时候把自己添加观察者的依赖中 */

notify() { ... } /* 通知所有订阅者 */

}

const targetStack = [] // watcher栈

export function pushTarget(_target: ?Watcher) { ... } /* 将watcher观察者实例设置给Dep.target,用以依赖收集。同时将该实例存入target栈中 */

export function popTarget() { ... } /* 将观察者实例从target栈中取出并设置给Dep.target */

这里,dep实例中SUB采集的依赖关系是watcher,它是watcher的一个实例,将来将用于通知更新

2.4观察者

// src/core/observer/watcher.js

/* 一个解析表达式,进行依赖收集的观察者,同时在表达式数据变更时触发回调函数。它被用于$watch api以及指令 */

export default class Watcher {

constructor(

vm: Component,

expOrFn: string | Function,

cb: Function,

options?: ?Object,

isRenderWatcher?: boolean // 是否是渲染watcher的标志位

) {

this.getter = expOrFn // 在get方法中执行

if (this.computed) { // 是否是 计算属性

this.value = undefined

this.dep = new Dep() // 计算属性创建过程中并未求值

} else { // 不是计算属性会立刻求值

this.value = this.get()

}

}

/* 获得getter的值并且重新进行依赖收集 */

get() {

pushTarget(this) // 设置Dep.target = this

let value

value = this.getter.call(vm, vm)

popTarget() // 将观察者实例从target栈中取出并设置给Dep.target

this.cleanupDeps()

return value

}

addDep(dep: Dep) { ... } /* 添加一个依赖关系到Deps集合中 */

cleanupDeps() { ... } /* 清理newDeps里没有的无用watcher依赖 */

update() { ... } /* 调度者接口,当依赖发生改变的时候进行回调 */

run() { ... } /* 调度者工作接口,将被调度者回调 */

getAndInvoke(cb: Function) { ... }

evaluate() { ... } /* 收集该watcher的所有deps依赖 */

depend() { ... } /* 收集该watcher的所有deps依赖,只有计算属性使用 */

teardown() { ... } /* 将自身从所有依赖收集订阅列表删除 */

}

get方法中执行的getter是updatecomponent=()=>;{VM._update(VM._render(),hydrating)},此方法从VM_render()开始生成渲染的vnode树。在此过程中,它访问当前Vue实例的VM上的数据,触发相应响应对象的getter,然后VM_uuUpdate()进行修补

注意,这里的get方法最终执行getandinvoke。此方法首先遍历存储在watcher中的DEP,删除不再在newdep中的订阅,然后depids=newdepids;DEPs=newdeps,清除newdepid和newdeps。每次添加新订阅时,不再需要的旧订阅都将被删除,以便在某些情况下,例如,当依赖于模板的数据发生变化时,V-IF不再需要该模板,观察者将不会收到更新通知

2.5总结

整个采集过程都与此有关。您可以将其与上述过程进行比较

观察者可在以下情况下使用:

只要它依赖于其他观察者,比如数据、数据属性、计算属性和道具,那么在闭包中就会生成一个dep实例dep,dep.dependent将在调用getter时采集依赖它的人,并将依赖的观察者存储在它自己的子中,即this.sub.push(sub),以便在更改时通知将其存储在dep.subs数组中。如果依赖它的观察者发生变化,请及时更新~

只要对象依赖于其他响应对象,就会生成一个观察者观察者来计算观察者依赖于哪些响应对象。在评估观察程序之前,将当前观察程序设置为全局dep.target,并在从属响应对象发生变化时及时更新它

本文是一个系列文章,稍后将进行更新以共同取得进展~

Vue源代码读取-文件结构和操作机制Vue源代码读取-依赖项采集原则Vue源代码读取-批量异步更新和nexttick原则

互联网上的大多数帖子深度不同,甚至相互矛盾。接下来的文章是学习过程的总结。如果您发现错误,欢迎您留言并指出~

参考:

Vue2.1.7源代码学习vue.js技术秘密分析vue.js内部运行机制vue.js文档【大干货】携手带您通过vue部分源代码学习vue.js源代码学习I-数据选项状态学习

关键词文章采集源码(采集站如何才能不被K站呢?(分享的是《)》)

采集交流 • 优采云 发表了文章 • 0 个评论 • 137 次浏览 • 2021-09-09 05:00

采集Station 还能做吗? 采集站还赚钱吗? 采集站怎么可能不是K站?现在大部分的网站都有采集other网站的内容,为什么能保证采集的内容排名好呢?不是采集能不能做到,只是垃圾,纯采集站绝对不行,采集文章只是网站内容的一部分。今天发错博客()分享了《采集站TitleSEO优化小窍门》。希望能帮到你。

一、采集如何做加权

文章采集站是太多人想做却做不到的事情。 网站 本身没有重量。你用一个刚注册的新域名,加上一堆采集垃圾邮件内容如何加权?正常来说,至少错的博客应该用一个网站历史好的旧域名,然后用一些原创文章来提高它的友好度,更好的伪原创也可以,但你不能。在发布之前整合信息并进行编辑,这比不更改任何内容就发布要好。

那么回到正题,采集站的权重如何?错误博客总结了以下几点:

1、老域名或基础站点

使用网站历史好的老域名,或者已经有好的收录和排名的网站,只用这两点作为基础,采集站的成功率会更高.

2、原创、伪原创 或集成编辑器文章

在你有老域名或者搜索性能好的网站后,坚持发布原创、伪原创或集成编辑文章一段时间,观察收录是否正常。

3、release采集

当一些比较好的文章可以正常收录之前,那就考虑发布采集的文章,毕竟纯采集的文章太多会影响搜索引擎的查看的网站。

二、采集站头SEO优化技巧

错误的博客看到了各种采集站名,觉得有一些特别的优点,所以在这里分享给大家。

1、insertion

在采集的原标题中插入这个词,但这会影响用户的阅读,但确实对搜索有欺骗作用。但是,如果插入单词,可能会缩短标题并添加另一个单词会更好,至少不会影响用户体验。

2、双词

太多网站采用了两个短句作为标题的形式。这个二字操作很有可能是直接把采集的两个字的内容合并到一起。这两个词又是关键词,所以一旦收录指数参与排名,一个文章可能会出现几个关键词。格式就像这篇文章的标题文章。

3、词不达意

很多网站比较随意,用了一批来自某行业采集大国文章的词,然后打乱了这些,直接用两个词作为标题,正文内容打乱了句或者段落被随机调用,更有可能使用伪原创工具批量伪原创。看来文章 基本上和原创 一样,但我真的读不下去了。这样的网站就算搞定了,一般也能活很久。

三、采集站做权重总结

错误的博客认为采集文章内容还可以,但不要纯采集站。搜索引擎攻击纯采集站,即那些超过采集而不说网站的站点无法合理转载。同时网站做一些原创的内容,转载一些高质量的文章,在这些高质量的文章下面添加评论,这样就没有问题了。另外,作为权重站,采集和关键词都带有百度指数,所以看起来网站的估计流量会更高。 查看全部

关键词文章采集源码(采集站如何才能不被K站呢?(分享的是《)》)

采集Station 还能做吗? 采集站还赚钱吗? 采集站怎么可能不是K站?现在大部分的网站都有采集other网站的内容,为什么能保证采集的内容排名好呢?不是采集能不能做到,只是垃圾,纯采集站绝对不行,采集文章只是网站内容的一部分。今天发错博客()分享了《采集站TitleSEO优化小窍门》。希望能帮到你。

一、采集如何做加权

文章采集站是太多人想做却做不到的事情。 网站 本身没有重量。你用一个刚注册的新域名,加上一堆采集垃圾邮件内容如何加权?正常来说,至少错的博客应该用一个网站历史好的旧域名,然后用一些原创文章来提高它的友好度,更好的伪原创也可以,但你不能。在发布之前整合信息并进行编辑,这比不更改任何内容就发布要好。

那么回到正题,采集站的权重如何?错误博客总结了以下几点:

1、老域名或基础站点

使用网站历史好的老域名,或者已经有好的收录和排名的网站,只用这两点作为基础,采集站的成功率会更高.

2、原创、伪原创 或集成编辑器文章

在你有老域名或者搜索性能好的网站后,坚持发布原创、伪原创或集成编辑文章一段时间,观察收录是否正常。

3、release采集

当一些比较好的文章可以正常收录之前,那就考虑发布采集的文章,毕竟纯采集的文章太多会影响搜索引擎的查看的网站。

二、采集站头SEO优化技巧

错误的博客看到了各种采集站名,觉得有一些特别的优点,所以在这里分享给大家。

1、insertion

在采集的原标题中插入这个词,但这会影响用户的阅读,但确实对搜索有欺骗作用。但是,如果插入单词,可能会缩短标题并添加另一个单词会更好,至少不会影响用户体验。

2、双词

太多网站采用了两个短句作为标题的形式。这个二字操作很有可能是直接把采集的两个字的内容合并到一起。这两个词又是关键词,所以一旦收录指数参与排名,一个文章可能会出现几个关键词。格式就像这篇文章的标题文章。

3、词不达意

很多网站比较随意,用了一批来自某行业采集大国文章的词,然后打乱了这些,直接用两个词作为标题,正文内容打乱了句或者段落被随机调用,更有可能使用伪原创工具批量伪原创。看来文章 基本上和原创 一样,但我真的读不下去了。这样的网站就算搞定了,一般也能活很久。

三、采集站做权重总结

错误的博客认为采集文章内容还可以,但不要纯采集站。搜索引擎攻击纯采集站,即那些超过采集而不说网站的站点无法合理转载。同时网站做一些原创的内容,转载一些高质量的文章,在这些高质量的文章下面添加评论,这样就没有问题了。另外,作为权重站,采集和关键词都带有百度指数,所以看起来网站的估计流量会更高。

关键词文章采集源码(WordPress代码禁止共享账号修改密码.php文件返回列表)

采集交流 • 优采云 发表了文章 • 0 个评论 • 127 次浏览 • 2021-09-08 11:07

简单的说,在文章标签中添加内链接,就是在文章中出现与标签相同的文字,文字会自动生成内链接。点击这个链接,你会看到所有收录标签的文章,

这不仅方便用户浏览和查询信息,还有助于搜索引擎抓取。

修改以下代码,复制到functions.php文件中

/* 自动为文章内的标签添加内链 */

$match_num_from = 1; //一篇文章中同一个标签少于几次不自动链接

$match_num_to = 1; //一篇文章中同一个标签最多自动链接几次

function tag_sort($a, $b){

if ( $a->name == $b->name ) return 0;

return ( strlen($a->name) > strlen($b->name) ) ? -1 : 1;

}

function tag_link($content){

global $match_num_from,$match_num_to;

$posttags = get_the_tags();

if ($posttags) {

usort($posttags, "tag_sort");

foreach($posttags as $tag) {

$link = get_tag_link($tag->term_id);

$keyword = $tag->name;

$cleankeyword = stripslashes($keyword);

$url = "<a href=\"$link\" title=\"".str_replace('%s',addcslashes($cleankeyword, '$'),__('【查看含有[%s]标签的文章】'))."\"";

$url .= ' target="_blank"';

$url .= ">".addcslashes($cleankeyword, '$')."</a>";

$limit = rand($match_num_from,$match_num_to);

$content = preg_replace( '|(]+>)(.*)('.$ex_word.')(.*)(]*>)|U'.$case, '$1$2%&&&&&%$4$5', $content);

$content = preg_replace( '|()|U'.$case, '$1$2%&&&&&%$4$5', $content);

$cleankeyword = preg_quote($cleankeyword,'\'');

$regEx = '\'(?!((]*?</a>))\'s' . $case;

$content = preg_replace($regEx,$url,$content,$limit);

$content = str_replace( '%&&&&&%', stripslashes($ex_word), $content);

}

}

return $content;

}

add_filter('the_content','tag_link',1);

返回列表

标签

上一篇:WordPress文章只允许网络爬虫/登录用户查看下一篇:WordPress代码禁止共享账号修改密码 查看全部

关键词文章采集源码(WordPress代码禁止共享账号修改密码.php文件返回列表)

简单的说,在文章标签中添加内链接,就是在文章中出现与标签相同的文字,文字会自动生成内链接。点击这个链接,你会看到所有收录标签的文章,

这不仅方便用户浏览和查询信息,还有助于搜索引擎抓取。

修改以下代码,复制到functions.php文件中

/* 自动为文章内的标签添加内链 */

$match_num_from = 1; //一篇文章中同一个标签少于几次不自动链接

$match_num_to = 1; //一篇文章中同一个标签最多自动链接几次

function tag_sort($a, $b){

if ( $a->name == $b->name ) return 0;

return ( strlen($a->name) > strlen($b->name) ) ? -1 : 1;

}

function tag_link($content){

global $match_num_from,$match_num_to;

$posttags = get_the_tags();

if ($posttags) {

usort($posttags, "tag_sort");

foreach($posttags as $tag) {

$link = get_tag_link($tag->term_id);

$keyword = $tag->name;

$cleankeyword = stripslashes($keyword);

$url = "<a href=\"$link\" title=\"".str_replace('%s',addcslashes($cleankeyword, '$'),__('【查看含有[%s]标签的文章】'))."\"";

$url .= ' target="_blank"';

$url .= ">".addcslashes($cleankeyword, '$')."</a>";

$limit = rand($match_num_from,$match_num_to);

$content = preg_replace( '|(]+>)(.*)('.$ex_word.')(.*)(]*>)|U'.$case, '$1$2%&&&&&%$4$5', $content);

$content = preg_replace( '|()|U'.$case, '$1$2%&&&&&%$4$5', $content);

$cleankeyword = preg_quote($cleankeyword,'\'');

$regEx = '\'(?!((]*?</a>))\'s' . $case;

$content = preg_replace($regEx,$url,$content,$limit);

$content = str_replace( '%&&&&&%', stripslashes($ex_word), $content);

}

}

return $content;

}

add_filter('the_content','tag_link',1);

返回列表

标签

上一篇:WordPress文章只允许网络爬虫/登录用户查看下一篇:WordPress代码禁止共享账号修改密码

关键词文章采集源码(淮北seo游戏推广网站源码、采集文章(关键词))

采集交流 • 优采云 发表了文章 • 0 个评论 • 121 次浏览 • 2021-10-10 00:18

游戏推广网站源码,采集文章。淮北seo游戏推广网站源代码2、对关键词做了很好的布局,标签合理,淮北seo游戏推广网站源代码描述、标签和网站地图安排关键词。 3、不要太密集。 网站 中的 关键词 密度太高。搜索引擎认为你在作弊,你会受到惩罚。 4、关键词 密度太高,搜索引擎认为你的刻意优化会降低你的网站的权重,导致整个网站的权重下降。 关键词 的布局不宜过大。搜索引擎不喜欢太密集的东西。不仅搜索引擎会认同你,用户也会觉得无聊,所以关键词的密度一定要掌握在6-8%之间。 4、网站导航,合理使用flash、javascript等,

搜索引擎认为您的 网站 不是很友好。铜陵seo企业网站推广5、网站的内容要以网站为主题,网站的内容不能围绕关键词。 6、网站的内容应该围绕网站的核心展开。 7、合理的网站内链建设,内容要围绕网站关键词进行,内链建设也要围绕网站@的内容进行>. 8、网站内页文章,应该有相关的文章推荐,这样可以增加pv,也可以加网站pv。 9、网站的内部链构建应该在文章的内容中合理穿插网站的关键词,并穿插文章 关键词、文章穿插关键词链接到相关网页,有助于提高您的网站被搜索引擎抓取,从而提高收录@ > 您的网页。 10、淮北seo游戏推广网站源码网站内部锚文本可以强化网站的关键词,为你完善搜索引擎网站 @> 认可,淮北seo游戏推广网站源码还可以提高网站在搜索引擎中的排名, 查看全部

关键词文章采集源码(淮北seo游戏推广网站源码、采集文章(关键词))

游戏推广网站源码,采集文章。淮北seo游戏推广网站源代码2、对关键词做了很好的布局,标签合理,淮北seo游戏推广网站源代码描述、标签和网站地图安排关键词。 3、不要太密集。 网站 中的 关键词 密度太高。搜索引擎认为你在作弊,你会受到惩罚。 4、关键词 密度太高,搜索引擎认为你的刻意优化会降低你的网站的权重,导致整个网站的权重下降。 关键词 的布局不宜过大。搜索引擎不喜欢太密集的东西。不仅搜索引擎会认同你,用户也会觉得无聊,所以关键词的密度一定要掌握在6-8%之间。 4、网站导航,合理使用flash、javascript等,

搜索引擎认为您的 网站 不是很友好。铜陵seo企业网站推广5、网站的内容要以网站为主题,网站的内容不能围绕关键词。 6、网站的内容应该围绕网站的核心展开。 7、合理的网站内链建设,内容要围绕网站关键词进行,内链建设也要围绕网站@的内容进行>. 8、网站内页文章,应该有相关的文章推荐,这样可以增加pv,也可以加网站pv。 9、网站的内部链构建应该在文章的内容中合理穿插网站的关键词,并穿插文章 关键词、文章穿插关键词链接到相关网页,有助于提高您的网站被搜索引擎抓取,从而提高收录@ > 您的网页。 10、淮北seo游戏推广网站源码网站内部锚文本可以强化网站的关键词,为你完善搜索引擎网站 @> 认可,淮北seo游戏推广网站源码还可以提高网站在搜索引擎中的排名,

关键词文章采集源码(翼速基于ThinkPHP微信小程序导航公众号导航网站源码下载 )

采集交流 • 优采云 发表了文章 • 0 个评论 • 163 次浏览 • 2021-10-04 21:14

)

易速应用精品源码下载,本站提供的开源版本可以任意打开两个,仅供开发者学习。目前,微信小程序和微信公众平台仍然是非常受欢迎的程序。本模型基于ThinkPHP微信小程序导航公众号导航网站源码,主要用于分享优质微信小程序和微信公众号。可以说是一款为微信小程序和公众号快速找到一个不错的123导航系统。

前端界面非常简洁优雅,是其他劣质同类微信小程序和微信公众号导航界面无法比拟的。前端也适配了手机WAP页面。设置后台WAP域名后,会自动识别手机。终端还是PC端,界面不合理,还有文章评价系统,对小程序或公众号进行评价,达到推广效果。

后台程序主要由ThinkPHP+ACEAdmin构建,可实现小程序、公众号的一键发布和修改,具有完整强大的权限管理机制。不同的用户可以根据不同的用户组设置不同的操作权限!!!

来源说明:

1.Thinkphp3.2开发,构建需要大于5.3的php版本不加密,任何二次开发都可以。

2.访问畅言评论,后台可开启/关闭

3. 进入帖子图库的图片存储,后台有个设置开关。

4. 后台设置配置丰富,几乎不需要修改代码,全部在后台控制。

5.缓存机制可以轻松应对大流量,缓存类型可以在后台选择。

6.完善的后台管理组权限,可以为不同的管理员分配不同的操作权限

###############安装方法:###############

完整包根目录解压后,第一次打开会提示安装。安装完成后根据每一步的提示,进入后台系统设置修改你的设置。

注:手机版需要解析手机版域名,然后在系统设置-其他设置中填写手机版域名。

伪静态规则在重写目录中,根据自己的服务器设置。

默认后台账号密码admin admin123

最后清除缓存。

QQ和微博快速登录配置:后台系统设置-其他设置配置中的QQ和微博配置。(暂时只做了QQ和微博,其他第三方登录都保留了,懂代码的可以自己研究)

查看全部

关键词文章采集源码(翼速基于ThinkPHP微信小程序导航公众号导航网站源码下载

)

易速应用精品源码下载,本站提供的开源版本可以任意打开两个,仅供开发者学习。目前,微信小程序和微信公众平台仍然是非常受欢迎的程序。本模型基于ThinkPHP微信小程序导航公众号导航网站源码,主要用于分享优质微信小程序和微信公众号。可以说是一款为微信小程序和公众号快速找到一个不错的123导航系统。

前端界面非常简洁优雅,是其他劣质同类微信小程序和微信公众号导航界面无法比拟的。前端也适配了手机WAP页面。设置后台WAP域名后,会自动识别手机。终端还是PC端,界面不合理,还有文章评价系统,对小程序或公众号进行评价,达到推广效果。

后台程序主要由ThinkPHP+ACEAdmin构建,可实现小程序、公众号的一键发布和修改,具有完整强大的权限管理机制。不同的用户可以根据不同的用户组设置不同的操作权限!!!

来源说明:

1.Thinkphp3.2开发,构建需要大于5.3的php版本不加密,任何二次开发都可以。

2.访问畅言评论,后台可开启/关闭

3. 进入帖子图库的图片存储,后台有个设置开关。

4. 后台设置配置丰富,几乎不需要修改代码,全部在后台控制。

5.缓存机制可以轻松应对大流量,缓存类型可以在后台选择。

6.完善的后台管理组权限,可以为不同的管理员分配不同的操作权限

###############安装方法:###############

完整包根目录解压后,第一次打开会提示安装。安装完成后根据每一步的提示,进入后台系统设置修改你的设置。

注:手机版需要解析手机版域名,然后在系统设置-其他设置中填写手机版域名。

伪静态规则在重写目录中,根据自己的服务器设置。

默认后台账号密码admin admin123

最后清除缓存。

QQ和微博快速登录配置:后台系统设置-其他设置配置中的QQ和微博配置。(暂时只做了QQ和微博,其他第三方登录都保留了,懂代码的可以自己研究)

关键词文章采集源码(本文:网站实时数据采集系统的设计与实现1.1)

采集交流 • 优采云 发表了文章 • 0 个评论 • 133 次浏览 • 2021-10-03 18:15

【摘要】随着经济技术的进步、互联网的普及和信息高速公路的发展,社会各个角落都有大量实时变化的数据。一些实时变化的数据与人们的生活息息相关,比如股票、外汇汇率等,虽然这些数据信息可以通过网站实时观察,但数据本身是无法获取的。本文针对这个问题设计了一个网站时间序列数据采集系统。针对当前网站data采集系统的种种不足,本文详细分析了网站data采集系统的需求,并对采集系统的需求进行了深入研究。网站 数据分析与提取 在此基础上,网站 实时时间序列数据< @采集系统的设计和实现,解决了网页数据获取的盲目性和网页数据本身无法访问的问题,实现了URL的自动生成和用户定位。数据、网页数据快速采集、数据查询和变化曲线生成等重要功能。本系统的重点是建立通用的网页数据解析规则,从而能够采集网站的大部分动态数据。采用多线程技术解决了网页下载时程序界面无响应的问题,通过建立配置文件解决了系统重启时复位的问题。Unicode 程序是“utf8”。系统界面力求简洁易用。菜单栏建立,整个界面只有一个按钮,所有的设置项都是通过弹出菜单来实现的。该程序是一个在Linux系统的Qt上实现的C++项目。这是作者第一次尝试在Linux系统上编程。该系统已经通过测试,效率较高,... 【摘要】随着科技的发展,信息的高速公路,每个角落都有大量的实时数据。一些与人的生活、股票、每个角落的大量实时数据。一些与人的生活、股票、每个角落的大量实时数据。一些与人的生活、股票、 查看全部

关键词文章采集源码(本文:网站实时数据采集系统的设计与实现1.1)

【摘要】随着经济技术的进步、互联网的普及和信息高速公路的发展,社会各个角落都有大量实时变化的数据。一些实时变化的数据与人们的生活息息相关,比如股票、外汇汇率等,虽然这些数据信息可以通过网站实时观察,但数据本身是无法获取的。本文针对这个问题设计了一个网站时间序列数据采集系统。针对当前网站data采集系统的种种不足,本文详细分析了网站data采集系统的需求,并对采集系统的需求进行了深入研究。网站 数据分析与提取 在此基础上,网站 实时时间序列数据< @采集系统的设计和实现,解决了网页数据获取的盲目性和网页数据本身无法访问的问题,实现了URL的自动生成和用户定位。数据、网页数据快速采集、数据查询和变化曲线生成等重要功能。本系统的重点是建立通用的网页数据解析规则,从而能够采集网站的大部分动态数据。采用多线程技术解决了网页下载时程序界面无响应的问题,通过建立配置文件解决了系统重启时复位的问题。Unicode 程序是“utf8”。系统界面力求简洁易用。菜单栏建立,整个界面只有一个按钮,所有的设置项都是通过弹出菜单来实现的。该程序是一个在Linux系统的Qt上实现的C++项目。这是作者第一次尝试在Linux系统上编程。该系统已经通过测试,效率较高,... 【摘要】随着科技的发展,信息的高速公路,每个角落都有大量的实时数据。一些与人的生活、股票、每个角落的大量实时数据。一些与人的生活、股票、每个角落的大量实时数据。一些与人的生活、股票、

关键词文章采集源码(做小说站无话可说的好程序有哪些?(图))

采集交流 • 优采云 发表了文章 • 0 个评论 • 139 次浏览 • 2021-10-01 08:02

来源介绍

来源说明:

深度定制小说网站,全自动采集各类网站,可自动生成首页、分类、目录、排名、站点地图页面、全站拼音目录、伪静态章节页面,自动生成小说txt文件,自动生成zip压缩包。这个源码功能非常强大!带来一个非常漂亮的手机页面!带采集规则+自动适配!超级强大,采集的所有规则都可以使用,并且全自动采集和存储,非常好用,特别适合优采云维护!对于一个新颖的网站来说,一个好的程序没什么好说的。

其他特性:

(1)首页、分类、目录、排名、站点地图页(分类页、小说封面、作者页,如果html文件不存在或超过设定时间未更新,则自动生成静态html)自动更新一次,如果有采集,当采集时会自动更新小说封面和对应的分类页面),直接通过PHP调用html文件,而不是在root中生成目录,访问速度和纯静态无异,在保证源代码文件管理方便的同时可以降低服务器压力,还可以方便访问统计,增加搜索引擎识别度。

(2)全站拼音编目,章节页面伪静态。

(3)小说txt文件自动生成,也可以后台重新生成txt文件。

(4)自动生成小说关键词和关键词自动内链。

(5)自动伪原创单词替换(采集时替换)。

(6)新增小说总点击量、月点击量、周点击量、总推荐量、月度推荐量、周推荐统计、作者推荐统计等功能。

(7)配合CNZZ的统计插件,方便实现小说下载量和藏书量的详细统计。

(8)本程序的自动采集不是市面上常见的优采云、广管、采集等,而是原有的采集功能DEDE基于采集模块二次开发,可有效保证章节内容的完整性,避免章节重复、章节内容无内容、章节乱码等;采集可达25~每天 24 小时 30 万个章节。

安装注意事项:

1、上传到网站的根目录

2、使用phpMyadmin导入数据库文件xiaoshuo.sql

3、修改数据库链接文件/data/common.inc.php

(切记不要用记事本修改,否则可能会出现验证码无法显示的问题,建议使用记事本++)

4、后台目录/admin/index.php

帐号管理员密码管理员

免责声明:本站尊重所有网络文件的版权问题。所有软件文件均来自网络。所有提供下载的软件和资源均由软件或程序作者提供,并由网友推荐。它们仅用于学习和研究。如果您侵犯了您的版权,请发邮件至邮箱:,本站将立即更正。本站绝对支持网络版权。

立即编辑终身VIP 查看全部

关键词文章采集源码(做小说站无话可说的好程序有哪些?(图))

来源介绍

来源说明:

深度定制小说网站,全自动采集各类网站,可自动生成首页、分类、目录、排名、站点地图页面、全站拼音目录、伪静态章节页面,自动生成小说txt文件,自动生成zip压缩包。这个源码功能非常强大!带来一个非常漂亮的手机页面!带采集规则+自动适配!超级强大,采集的所有规则都可以使用,并且全自动采集和存储,非常好用,特别适合优采云维护!对于一个新颖的网站来说,一个好的程序没什么好说的。

其他特性:

(1)首页、分类、目录、排名、站点地图页(分类页、小说封面、作者页,如果html文件不存在或超过设定时间未更新,则自动生成静态html)自动更新一次,如果有采集,当采集时会自动更新小说封面和对应的分类页面),直接通过PHP调用html文件,而不是在root中生成目录,访问速度和纯静态无异,在保证源代码文件管理方便的同时可以降低服务器压力,还可以方便访问统计,增加搜索引擎识别度。

(2)全站拼音编目,章节页面伪静态。

(3)小说txt文件自动生成,也可以后台重新生成txt文件。

(4)自动生成小说关键词和关键词自动内链。

(5)自动伪原创单词替换(采集时替换)。

(6)新增小说总点击量、月点击量、周点击量、总推荐量、月度推荐量、周推荐统计、作者推荐统计等功能。

(7)配合CNZZ的统计插件,方便实现小说下载量和藏书量的详细统计。

(8)本程序的自动采集不是市面上常见的优采云、广管、采集等,而是原有的采集功能DEDE基于采集模块二次开发,可有效保证章节内容的完整性,避免章节重复、章节内容无内容、章节乱码等;采集可达25~每天 24 小时 30 万个章节。

安装注意事项:

1、上传到网站的根目录

2、使用phpMyadmin导入数据库文件xiaoshuo.sql

3、修改数据库链接文件/data/common.inc.php

(切记不要用记事本修改,否则可能会出现验证码无法显示的问题,建议使用记事本++)

4、后台目录/admin/index.php

帐号管理员密码管理员

免责声明:本站尊重所有网络文件的版权问题。所有软件文件均来自网络。所有提供下载的软件和资源均由软件或程序作者提供,并由网友推荐。它们仅用于学习和研究。如果您侵犯了您的版权,请发邮件至邮箱:,本站将立即更正。本站绝对支持网络版权。

立即编辑终身VIP

关键词文章采集源码(运行环境nt/2003orFramework1.12000开发环境VS2003)

采集交流 • 优采云 发表了文章 • 0 个评论 • 95 次浏览 • 2021-09-28 17:20

看预览图: 运行环境 windows nt/xp/2003 or Framework 1.1SqlServer 2000 开发环境 VS 2003 目的 学习网络编程后,总有事可做。于是我想到了做一个网页内容采集器。作者主页:使用方法 测试数据来自cnBlog。如下图所示,用户首先填写“起始页”,即从哪个页面开始采集。然后填写数据库连接字符串,这里是采集的数据插入的数据库定义,然后选择表名,不用说了。网页编码,如果不出意外,中国大陆可以用UTF-8来抓取文件名正则:呵呵,这个工具显然是给程序员用的。您必须直接填写常规规则。例如,cnblogs都是数字,所以写\d来建表帮助:用户指定创建几个varchar类型,几个text类型,主要放短数据和长数据。如果您的表中已经有列,请避免使用它们。程序中没有验证。在网页设置中:采集标签前后的内容:比如有xxx,如果我要采集xxx,就写“to”,当然就是to之间的内容. 接下来的几个文本框用于显示内容。点击“获取网址”,查看它抓取的网址是否正确。点击“采集”将采集的内容放入数据库,然后使用Insert xx()(选择xx)直接插入目标数据。程序代码量很小(而且很简陋),需要做一些改动。缺点应用于正则表达式和网络编程,因为它们是最简单的东西,所以没有使用多线程,没有其他优化方法,也不支持分页。我测试了一下,得到了38条数据,使用了700M内存。. . . 如果你有用,你可以改变它。方便程序员使用,无需编写大量代码。Surance Yin@ Surance Center 转载请注明出处 查看全部

关键词文章采集源码(运行环境nt/2003orFramework1.12000开发环境VS2003)

看预览图: 运行环境 windows nt/xp/2003 or Framework 1.1SqlServer 2000 开发环境 VS 2003 目的 学习网络编程后,总有事可做。于是我想到了做一个网页内容采集器。作者主页:使用方法 测试数据来自cnBlog。如下图所示,用户首先填写“起始页”,即从哪个页面开始采集。然后填写数据库连接字符串,这里是采集的数据插入的数据库定义,然后选择表名,不用说了。网页编码,如果不出意外,中国大陆可以用UTF-8来抓取文件名正则:呵呵,这个工具显然是给程序员用的。您必须直接填写常规规则。例如,cnblogs都是数字,所以写\d来建表帮助:用户指定创建几个varchar类型,几个text类型,主要放短数据和长数据。如果您的表中已经有列,请避免使用它们。程序中没有验证。在网页设置中:采集标签前后的内容:比如有xxx,如果我要采集xxx,就写“to”,当然就是to之间的内容. 接下来的几个文本框用于显示内容。点击“获取网址”,查看它抓取的网址是否正确。点击“采集”将采集的内容放入数据库,然后使用Insert xx()(选择xx)直接插入目标数据。程序代码量很小(而且很简陋),需要做一些改动。缺点应用于正则表达式和网络编程,因为它们是最简单的东西,所以没有使用多线程,没有其他优化方法,也不支持分页。我测试了一下,得到了38条数据,使用了700M内存。. . . 如果你有用,你可以改变它。方便程序员使用,无需编写大量代码。Surance Yin@ Surance Center 转载请注明出处

关键词文章采集源码(素材代下载搜索引擎系统/自带/源码素材付费下载系统)

采集交流 • 优采云 发表了文章 • 0 个评论 • 174 次浏览 • 2021-09-28 16:40

源代码名称:

素材下载搜索引擎系统/自带/源码付费下载系统/全站打包完善运行版源码下载

来源说明:

材料代下的行业在互联网上也有点历史。这几年前图网、牛图网、窝图网生成的网站图片素材更是牛逼,好玩的模板源码网也买了。法,这代的源码有点不一样,是源码下载源码网的源码,所以比较新,从500朋友那里买的。

程序原创开发,支付对接轻松支付,代码支付,全站数据和域名出售,百度搜狗关键词:源码生成,生成源码,都在首页

缺点:此用户登录必须连接QQ上网登录,有能力的可以自己注册登录

1、采用了新的php+mysql框架,特征码没有被百度抓取,所以收录的效果和权重提升的效果就不讨论了。

2、mysql数据库,自己导入关键词,自己行业导入即可

3、 聚焦并推送自己的行业词汇,避免收录无关的关键词

4、整体UI界面优化更简洁,用户进来也不会觉得是垃圾站

5、合理的SEO优化结构,病毒式传播,组合,让蜘蛛自由爬行收录

6、 无壳,无蜘蛛池,无需租二级目录,只是一个旧域名

7、突破百度冰桶算法5.0

8、是目前最有效、最稳定、最简单、最划算、排名第一的程序

源代码截图:

[相关下载] 会员免费下载。非会员可单独购买

点击下载 查看全部

关键词文章采集源码(素材代下载搜索引擎系统/自带/源码素材付费下载系统)

源代码名称:

素材下载搜索引擎系统/自带/源码付费下载系统/全站打包完善运行版源码下载

来源说明:

材料代下的行业在互联网上也有点历史。这几年前图网、牛图网、窝图网生成的网站图片素材更是牛逼,好玩的模板源码网也买了。法,这代的源码有点不一样,是源码下载源码网的源码,所以比较新,从500朋友那里买的。

程序原创开发,支付对接轻松支付,代码支付,全站数据和域名出售,百度搜狗关键词:源码生成,生成源码,都在首页

缺点:此用户登录必须连接QQ上网登录,有能力的可以自己注册登录

1、采用了新的php+mysql框架,特征码没有被百度抓取,所以收录的效果和权重提升的效果就不讨论了。

2、mysql数据库,自己导入关键词,自己行业导入即可

3、 聚焦并推送自己的行业词汇,避免收录无关的关键词

4、整体UI界面优化更简洁,用户进来也不会觉得是垃圾站

5、合理的SEO优化结构,病毒式传播,组合,让蜘蛛自由爬行收录

6、 无壳,无蜘蛛池,无需租二级目录,只是一个旧域名

7、突破百度冰桶算法5.0

8、是目前最有效、最稳定、最简单、最划算、排名第一的程序

源代码截图:

[相关下载] 会员免费下载。非会员可单独购买

点击下载

关键词文章采集源码(2021年新版PTCMS小说精美多风格四套全新版本在线听书带下载插件)

采集交流 • 优采云 发表了文章 • 0 个评论 • 179 次浏览 • 2021-09-27 17:10

2021年PTcms小说新版精美多风格四套新版在线听书带下载插件.zip

2021年PTcms小说新版精美多风格。新版四套是带下载插件的在线听书。给大家介绍一下PTcms的教程。功能介绍:新开发,新版UI,增加原创专区,新闻发布,书单发布,采集日志,百度推送,神马推送,推送日志功能。前端高仿起点小说网,自适应模板,可分手机域名。后端是用LAYUI新开发的。以下是设置内容: 一、 服务器环境需要推荐的linux环境,win也支持,不过我没有测试设置,按照下面的教程自己测试。以下是我搭建nginx的环境1. 15 MySQL 5.5 php7.3 install php extension fileinfo memcached swoole4 在php7.3二、configure Swoole1、的disable函数中删除shell exec /www/在server/文件中创建ptcms文件夹,将license和loader73.so上传到ptcms,2、打开php的配置文件7.3(并调用php.ini)拉到底,添加以下两行代码,保存,重启php,如果报错,检查以上步骤有没有错误!extension=/www/server/ptcms/loader73.so swoole_license_files=/www/server/ptcms/license三、配置网站设置,< @1、点击网站——点击站点名称或设置2、设置网站运行目录为public<

下面说一下配置cron启动主进程。启动方式是1、 首先,我们可以使用SHH链接工具,或者直接连接宝塔的SHH连接。2、 进入shh连接页面,需要登录连接服务器输入以下代码,进入网站目录,看我截图cd/www/wwwroot/网站 root目录名然后输入以下代码启动主进程任务,我已经启动了这个,所以很正常。一开始看起来像下图 /www/server/php/73/bin/phpkxcron:check 现在我们回到后台刷新页面,可以再次看到流程采集,点击自动开启刷新,会自动刷新页面,基本的安装和设置都到这里了,现在来说说列表< @采集设置分页和后台设置分页采集。分页规则应由 [page] 设置。设置列表时,选择前台或后台离线。前台浏览器不能关闭,浏览器和电脑都可以关闭。起始页可以从任何页面开始,前提是目标站点有此页,结束页相同,且必须等于或大于起始页。设置后台任务页面采集 点击任务进入下一页。附加参数:"start/*/end/#" *和#分别填写起始采集页码和结束采集页码对应位置;对应规则,参数填写为“开始/开始页码/结束/结束页码”,

现在就下载 查看全部

关键词文章采集源码(2021年新版PTCMS小说精美多风格四套全新版本在线听书带下载插件)

2021年PTcms小说新版精美多风格四套新版在线听书带下载插件.zip

2021年PTcms小说新版精美多风格。新版四套是带下载插件的在线听书。给大家介绍一下PTcms的教程。功能介绍:新开发,新版UI,增加原创专区,新闻发布,书单发布,采集日志,百度推送,神马推送,推送日志功能。前端高仿起点小说网,自适应模板,可分手机域名。后端是用LAYUI新开发的。以下是设置内容: 一、 服务器环境需要推荐的linux环境,win也支持,不过我没有测试设置,按照下面的教程自己测试。以下是我搭建nginx的环境1. 15 MySQL 5.5 php7.3 install php extension fileinfo memcached swoole4 在php7.3二、configure Swoole1、的disable函数中删除shell exec /www/在server/文件中创建ptcms文件夹,将license和loader73.so上传到ptcms,2、打开php的配置文件7.3(并调用php.ini)拉到底,添加以下两行代码,保存,重启php,如果报错,检查以上步骤有没有错误!extension=/www/server/ptcms/loader73.so swoole_license_files=/www/server/ptcms/license三、配置网站设置,< @1、点击网站——点击站点名称或设置2、设置网站运行目录为public<

下面说一下配置cron启动主进程。启动方式是1、 首先,我们可以使用SHH链接工具,或者直接连接宝塔的SHH连接。2、 进入shh连接页面,需要登录连接服务器输入以下代码,进入网站目录,看我截图cd/www/wwwroot/网站 root目录名然后输入以下代码启动主进程任务,我已经启动了这个,所以很正常。一开始看起来像下图 /www/server/php/73/bin/phpkxcron:check 现在我们回到后台刷新页面,可以再次看到流程采集,点击自动开启刷新,会自动刷新页面,基本的安装和设置都到这里了,现在来说说列表< @采集设置分页和后台设置分页采集。分页规则应由 [page] 设置。设置列表时,选择前台或后台离线。前台浏览器不能关闭,浏览器和电脑都可以关闭。起始页可以从任何页面开始,前提是目标站点有此页,结束页相同,且必须等于或大于起始页。设置后台任务页面采集 点击任务进入下一页。附加参数:"start/*/end/#" *和#分别填写起始采集页码和结束采集页码对应位置;对应规则,参数填写为“开始/开始页码/结束/结束页码”,

现在就下载

关键词文章采集源码(如何应对网络中的新闻内容也一样?系统帮你解决)

采集交流 • 优采云 发表了文章 • 0 个评论 • 124 次浏览 • 2021-09-27 17:07

随着互联网的飞速发展,互联网极大地提高了信息生成和传播的速度。互联网上每天都会产生大量的内容。如何从这些杂乱无章的内容中高效地发现和采集需要的信息似乎越来越多。越重要。互联网上的新闻内容也是如此。新闻分布在不同的网站上,存在重复的内容。我们往往只关心一些新闻。互联网上的新闻页面往往充斥着大量与新闻无关的新闻页面。这些信息会影响我们的阅读效率和阅读体验。如何更方便、及时、高效地获取我们关心的新闻内容,这个系统可以帮我们做到这一点。本系统利用网络爬虫对互联网上的新闻进行定时、有针对性的分析和采集,然后对采集接收到的数据进行去重、分类和存储。进入数据库,最终提供个性化的新闻订阅服务。考虑如何处理网站的反爬虫策略,避免被网站拦截。在具体的实现中,会使用Python和scrapy等框架来编写爬虫,使用特定的内容提取算法来提取目标数据。最后使用Django和weui提供新闻订阅后台和新闻内容展示页面,使用微信向用户推送信息。用户可以通过本系统订阅指定关键词,

[关键词] 网络爬虫;消息; 个性化;订阅; Python

参考文档及完整文档及源代码下载地址: 查看全部

关键词文章采集源码(如何应对网络中的新闻内容也一样?系统帮你解决)

随着互联网的飞速发展,互联网极大地提高了信息生成和传播的速度。互联网上每天都会产生大量的内容。如何从这些杂乱无章的内容中高效地发现和采集需要的信息似乎越来越多。越重要。互联网上的新闻内容也是如此。新闻分布在不同的网站上,存在重复的内容。我们往往只关心一些新闻。互联网上的新闻页面往往充斥着大量与新闻无关的新闻页面。这些信息会影响我们的阅读效率和阅读体验。如何更方便、及时、高效地获取我们关心的新闻内容,这个系统可以帮我们做到这一点。本系统利用网络爬虫对互联网上的新闻进行定时、有针对性的分析和采集,然后对采集接收到的数据进行去重、分类和存储。进入数据库,最终提供个性化的新闻订阅服务。考虑如何处理网站的反爬虫策略,避免被网站拦截。在具体的实现中,会使用Python和scrapy等框架来编写爬虫,使用特定的内容提取算法来提取目标数据。最后使用Django和weui提供新闻订阅后台和新闻内容展示页面,使用微信向用户推送信息。用户可以通过本系统订阅指定关键词,

[关键词] 网络爬虫;消息; 个性化;订阅; Python

参考文档及完整文档及源代码下载地址:

关键词文章采集源码(2017年10月29日更新如下:插件实现的功能)

采集交流 • 优采云 发表了文章 • 0 个评论 • 129 次浏览 • 2021-09-27 13:18

安装此PHPcms模块后,采集器控制面板将出现在版本的顶部文章。在发布编辑框中输入关键词或网站智能采集内容。它具有易学、易懂、易用、成熟、稳定的特点。它是PHPcms新手站长和网站编辑必备的模块

插件实现的功能如下:

1、最新最热门的微信官方账号文章采集每天都会自动更新。p>

2、最新最热门的信息采集,每天自动更新

3、输入关键词,采集与关键词相关的最新内容

4、输入内容页面的URL和此页面的内容

5、支持云通用伪原创

6、支持采集优酷视频、腾讯视频和56视频

7、支持微信公众号视频采集

8、支持特殊的垂直方向采集

如笑话、图片、视频、微信公众号等

9、支持自动内容布局

10、支持批量采集和批量发布

11、支持三种编辑器:fck、CK和UE

2017年10月29日更新如下:

1、根据关键词采集

2、您可以定制伪原创同义词表,以实现采集和收录的双赢局面

3、新的实时采集、批量采集、网站采集等

软件名称:

中大运采集PHPcmsV版9.0

软件语言:

简体中文

源代码大小:

842 KB

操作平台:

PHP/Mysql

软件许可:

免费版江苏电信下载内蒙古网通下载 查看全部

关键词文章采集源码(2017年10月29日更新如下:插件实现的功能)

安装此PHPcms模块后,采集器控制面板将出现在版本的顶部文章。在发布编辑框中输入关键词或网站智能采集内容。它具有易学、易懂、易用、成熟、稳定的特点。它是PHPcms新手站长和网站编辑必备的模块

插件实现的功能如下:

1、最新最热门的微信官方账号文章采集每天都会自动更新。p>

2、最新最热门的信息采集,每天自动更新

3、输入关键词,采集与关键词相关的最新内容

4、输入内容页面的URL和此页面的内容

5、支持云通用伪原创

6、支持采集优酷视频、腾讯视频和56视频

7、支持微信公众号视频采集

8、支持特殊的垂直方向采集

如笑话、图片、视频、微信公众号等

9、支持自动内容布局

10、支持批量采集和批量发布

11、支持三种编辑器:fck、CK和UE

2017年10月29日更新如下:

1、根据关键词采集

2、您可以定制伪原创同义词表,以实现采集和收录的双赢局面

3、新的实时采集、批量采集、网站采集等

软件名称:

中大运采集PHPcmsV版9.0

软件语言:

简体中文

源代码大小:

842 KB

操作平台:

PHP/Mysql

软件许可:

免费版江苏电信下载内蒙古网通下载

关键词文章采集源码(一个跟踪关键字资讯收集的程序--一个之Spider)

采集交流 • 优采云 发表了文章 • 0 个评论 • 126 次浏览 • 2021-09-27 10:16

投资者都知道,早、晚、晚有很多信息需要关注,包括政府政策(国务院、央行、证监会、统计局)、新闻披露(交易所、新闻更新) 、公司公告、门户网站)。网站)、财务审计(财报公告、审计机构)等。随着研究的深入,信息量越来越大,每天花在这上面的时间会越来越多,就像无底洞一样投资不一定有收益,但不投资的风险太大。任何异常事件都会造成致命的损失。基于此,作者开发了一个程序来跟踪关键字信息的采集。

一、思考

作者的灵感来源是百度搜索。其实我们每天都可以得到百度搜索关键词的信息,只是来源太杂乱。当然,通过过滤URL可以找到真实的信息,但是时间成本太高,而且还存在抓取不及时、信息不全等现象,参考以下案例:

site:: 限制搜索范围,只搜索

“中国平安”:完全匹配,只查找收录“中国平安”完整字段的内容

借鉴百度搜索的思路,作者直接通过python从需要关注的网页中抓取网页内容,通过网页内容找到关键词,解决了上述关键词关注的问题。因此,作者使用统计关键词来达到查看网站相关信息的目的,从而节省时间。以下是作者的实现代码:

二、有一些问题网站。我们看到的内容和我们通过“查看网页源代码”的方式看到的内容是不一样的。它们之间可能有一个跳转过程。这时,通过程序计算的统计结果会与实际结果有所不同。(如果有解决方法的读者朋友看到,请联系作者)

参考

1.Github 之蜘蛛源代码 查看全部

关键词文章采集源码(一个跟踪关键字资讯收集的程序--一个之Spider)

投资者都知道,早、晚、晚有很多信息需要关注,包括政府政策(国务院、央行、证监会、统计局)、新闻披露(交易所、新闻更新) 、公司公告、门户网站)。网站)、财务审计(财报公告、审计机构)等。随着研究的深入,信息量越来越大,每天花在这上面的时间会越来越多,就像无底洞一样投资不一定有收益,但不投资的风险太大。任何异常事件都会造成致命的损失。基于此,作者开发了一个程序来跟踪关键字信息的采集。

一、思考

作者的灵感来源是百度搜索。其实我们每天都可以得到百度搜索关键词的信息,只是来源太杂乱。当然,通过过滤URL可以找到真实的信息,但是时间成本太高,而且还存在抓取不及时、信息不全等现象,参考以下案例:

site:: 限制搜索范围,只搜索

“中国平安”:完全匹配,只查找收录“中国平安”完整字段的内容

借鉴百度搜索的思路,作者直接通过python从需要关注的网页中抓取网页内容,通过网页内容找到关键词,解决了上述关键词关注的问题。因此,作者使用统计关键词来达到查看网站相关信息的目的,从而节省时间。以下是作者的实现代码:

二、有一些问题网站。我们看到的内容和我们通过“查看网页源代码”的方式看到的内容是不一样的。它们之间可能有一个跳转过程。这时,通过程序计算的统计结果会与实际结果有所不同。(如果有解决方法的读者朋友看到,请联系作者)

参考

1.Github 之蜘蛛源代码

关键词文章采集源码(聊城市东昌府区太之*信息科技**ST88会员优化关键词)

采集交流 • 优采云 发表了文章 • 0 个评论 • 121 次浏览 • 2021-09-25 01:08

聊城市东昌府区太直

**:太智* 服务区域:全国推广范围:全国

我公司业务:百度招投标、百度优化、百度爱采购、百度爱采购招标、百度下拉框、MWordba画面、制作网站、优化关键词、B2B网站平台会员一代Open、B2B网站发帖软件、小程序开发、百度搜索下拉框、百度竞价包月、MWordba屏、迅瓜瓜等。

您可以使用发帖软件,但您不会使用其他软件。由于该软件具有欺骗性,您可能会在购买后打开该软件。

您可以先注册**使用本软件,您可以使用并适应这种发帖方式后才能申请软件会员

因此您在使用该软件时不会承担任何风险

黄页88 会员代理开通优化关键词 虽然网上有类似勤发发软件的工具,但发布数量有限,只有一个。网站,操作步骤麻烦,收费高

内容:发布的内容也很重要。我们建议: ①不要抄袭内容,即使是抄袭,也尽量抄袭你的官方网站。抄袭别人,一定要改一些,抄袭很难搜索引擎收录;②? 内容应尽可能丰富。所谓丰富不是堆积无用的文字,而应该与标题有关。是便于客户阅读的分层内容;③? 文字要自然出现 关键词 ,不要堆砌关键词,在文中留下联系方式,如,,网址等4.域名whois同域名,有一定没有不良历史记录,比如你之前的网站如果你曾经K过,或者做过非法网站,注册新域名时尽量不要使用自己的个人域名。大量非法站点使用更便宜的域名,成本相对较低。搜索引擎将使用这些域名。网站 被视为非法站点。如果我们使用这样的域名,就相当于进入了搜索引擎的黑名单。

<p>黄页88会员优化关键词3、网站结构**网站结构也会影响网站2、放弃网站的排名@> 在一定程度上。@采集文章现在搜索引擎一直在强调网站的用户体验,一个网站如果有很多 查看全部

关键词文章采集源码(聊城市东昌府区太之*信息科技**ST88会员优化关键词)

聊城市东昌府区太直

**:太智* 服务区域:全国推广范围:全国

我公司业务:百度招投标、百度优化、百度爱采购、百度爱采购招标、百度下拉框、MWordba画面、制作网站、优化关键词、B2B网站平台会员一代Open、B2B网站发帖软件、小程序开发、百度搜索下拉框、百度竞价包月、MWordba屏、迅瓜瓜等。

您可以使用发帖软件,但您不会使用其他软件。由于该软件具有欺骗性,您可能会在购买后打开该软件。

您可以先注册**使用本软件,您可以使用并适应这种发帖方式后才能申请软件会员

因此您在使用该软件时不会承担任何风险

黄页88 会员代理开通优化关键词 虽然网上有类似勤发发软件的工具,但发布数量有限,只有一个。网站,操作步骤麻烦,收费高

内容:发布的内容也很重要。我们建议: ①不要抄袭内容,即使是抄袭,也尽量抄袭你的官方网站。抄袭别人,一定要改一些,抄袭很难搜索引擎收录;②? 内容应尽可能丰富。所谓丰富不是堆积无用的文字,而应该与标题有关。是便于客户阅读的分层内容;③? 文字要自然出现 关键词 ,不要堆砌关键词,在文中留下联系方式,如,,网址等4.域名whois同域名,有一定没有不良历史记录,比如你之前的网站如果你曾经K过,或者做过非法网站,注册新域名时尽量不要使用自己的个人域名。大量非法站点使用更便宜的域名,成本相对较低。搜索引擎将使用这些域名。网站 被视为非法站点。如果我们使用这样的域名,就相当于进入了搜索引擎的黑名单。

<p>黄页88会员优化关键词3、网站结构**网站结构也会影响网站2、放弃网站的排名@> 在一定程度上。@采集文章现在搜索引擎一直在强调网站的用户体验,一个网站如果有很多

关键词文章采集源码(l3232nzx如何确保服务器稳定工作?(图))

采集交流 • 优采云 发表了文章 • 0 个评论 • 246 次浏览 • 2021-09-22 08:23

吉林关键词采集外部设备 - 行业经验丰富L32NZX

确保服务器稳定。服务器的稳定性不仅与用户体验问题有关,而且对捕获也有很大的影响。 SEO应检查服务器状态,查看网站日志,检查是否有500个状态代码或其他标记,并找到隐藏危险的存在。

SEO的主要工作是通过了解各种搜索引擎如何捕获Internet页面,如何索引,以及如何确定其技术,如搜索结果的特定关键词等。它改善了搜索引擎排名,从而增加网站 @访问,*结束增强网站的销售能力或促销能力技术。吉林关键词采集外包服务。

季度网站更新:通常@ @ @ @ @ @ @ @ @ @提期会,距,因此*初始高级排名只有一半的成功,搜索引擎是不断变化的算法。自然搜索引擎优化和营销目标全部更新每个季度客户网站,并不断更改搜索引擎的显示。这些更新将通过搜索引擎的算法促进额外的产品关键字。搜索引擎优化不仅仅是结果,而且是一个连续的过程。

百度节拍屏幕是A *常规SEO操作方法,它是SEO的*思维,其本质是:使用高强有力的第三方平台做你想要的是关键词因为第三方平台的高重量可以快速获得排名,导致姜黄和排水的影响。当然,潘站群,黑人站点有很多技术,并跳进百度暴君,但这些技术适用于短暂的项目,不适合企业站。吉林关键词采集外包服务。

防止标题重复:在页面的结构中,您应该注意不使用重复的标题。这也将使用户没有真诚,确保每个页面具有相对独立的分页,防止重复性内容,它可以显示更好的想法和规范,允许用户达到网页图像的新高度。

百度将排序信息。所有来百度搜索的人,他们想快速找到自己的答案,百度也了解客户的想法,所以他们开发了一套计划,排序所有这些抢手的信息,然后把他相信好的答案在前面排名并为客户提供。

网站也与seo服务相同,也是网站的重量,除了指定的查找引擎@ @ @ @ @ @ @ @ @ @ @ @ @ @ @ @ @ @ @ @ @ @ @ @ @ @ @ @ @ @ @ @ @ @ managersy over网络营销实现人们估计没有人不知道SEO,即寻找发动机优化,这是一种在搜索搜索引擎排名中寻找搜索引擎的方法。吉林关键词采集外包服务。

网站 ranking迅速:有一定的营销技术和网络体验,您可以让网站在数千次竞争中网站,发现潜在客户所需的信息*时间。产品信息涵盖所有主要网络:公共信息,产品信息在主要网络中发布,允许业务信息涵盖大型网络。

写一个文章:太短文章 @ @ @ @ @ @ @ @ 爱站不不,一般操纵每个文章至少300字。另一方面,不要让文章似乎太长,因为这不会有利于重要词语的密度,文章似乎是紧凑的。讨论显示太长文章将迅速减少读者的数量,他们选择关闭文章。

事实上,许多人正在讨论SEO和SEM之间的关系。在我看来,SEO和SEM是一种不干涉的关系,但也相互影响。两种方式都可以单独运行,但一旦SEO运行,效果会好得多,SEO基本上是收录,有收录有排名,将有流量,流量,流量,流量,流量, 查看全部

关键词文章采集源码(l3232nzx如何确保服务器稳定工作?(图))

吉林关键词采集外部设备 - 行业经验丰富L32NZX

确保服务器稳定。服务器的稳定性不仅与用户体验问题有关,而且对捕获也有很大的影响。 SEO应检查服务器状态,查看网站日志,检查是否有500个状态代码或其他标记,并找到隐藏危险的存在。

SEO的主要工作是通过了解各种搜索引擎如何捕获Internet页面,如何索引,以及如何确定其技术,如搜索结果的特定关键词等。它改善了搜索引擎排名,从而增加网站 @访问,*结束增强网站的销售能力或促销能力技术。吉林关键词采集外包服务。

季度网站更新:通常@ @ @ @ @ @ @ @ @ @提期会,距,因此*初始高级排名只有一半的成功,搜索引擎是不断变化的算法。自然搜索引擎优化和营销目标全部更新每个季度客户网站,并不断更改搜索引擎的显示。这些更新将通过搜索引擎的算法促进额外的产品关键字。搜索引擎优化不仅仅是结果,而且是一个连续的过程。

百度节拍屏幕是A *常规SEO操作方法,它是SEO的*思维,其本质是:使用高强有力的第三方平台做你想要的是关键词因为第三方平台的高重量可以快速获得排名,导致姜黄和排水的影响。当然,潘站群,黑人站点有很多技术,并跳进百度暴君,但这些技术适用于短暂的项目,不适合企业站。吉林关键词采集外包服务。

防止标题重复:在页面的结构中,您应该注意不使用重复的标题。这也将使用户没有真诚,确保每个页面具有相对独立的分页,防止重复性内容,它可以显示更好的想法和规范,允许用户达到网页图像的新高度。

百度将排序信息。所有来百度搜索的人,他们想快速找到自己的答案,百度也了解客户的想法,所以他们开发了一套计划,排序所有这些抢手的信息,然后把他相信好的答案在前面排名并为客户提供。

网站也与seo服务相同,也是网站的重量,除了指定的查找引擎@ @ @ @ @ @ @ @ @ @ @ @ @ @ @ @ @ @ @ @ @ @ @ @ @ @ @ @ @ @ @ @ @ @ managersy over网络营销实现人们估计没有人不知道SEO,即寻找发动机优化,这是一种在搜索搜索引擎排名中寻找搜索引擎的方法。吉林关键词采集外包服务。

网站 ranking迅速:有一定的营销技术和网络体验,您可以让网站在数千次竞争中网站,发现潜在客户所需的信息*时间。产品信息涵盖所有主要网络:公共信息,产品信息在主要网络中发布,允许业务信息涵盖大型网络。

写一个文章:太短文章 @ @ @ @ @ @ @ @ 爱站不不,一般操纵每个文章至少300字。另一方面,不要让文章似乎太长,因为这不会有利于重要词语的密度,文章似乎是紧凑的。讨论显示太长文章将迅速减少读者的数量,他们选择关闭文章。

事实上,许多人正在讨论SEO和SEM之间的关系。在我看来,SEO和SEM是一种不干涉的关系,但也相互影响。两种方式都可以单独运行,但一旦SEO运行,效果会好得多,SEO基本上是收录,有收录有排名,将有流量,流量,流量,流量,流量,

关键词文章采集源码(:关键词文章采集源码及配置采集前的准备)

采集交流 • 优采云 发表了文章 • 0 个评论 • 140 次浏览 • 2021-09-19 20:04

关键词文章采集源码及配置采集前准备我们需要在写博客的时候准备好我们需要采集的文章列表,比如:找死的python与sqlmap之间的对比。针对采集某一数据源、某一文章进行采集。因为我们是自己写的采集,所以我们先需要搞定这两点。准备好我们采集的源码。编写文章采集的代码文章采集一般是带有tags标签的,tags我们可以在页面上获取到,也可以通过xpath获取到。

我们将这篇文章里的内容tags命名为“user-agent”。打开mysql的select查询,查看row返回值的值和data值。根据我们刚才获取到的返回值,我们发现。所有字段值都是我们自己定义的,与采集其他字段没有任何关系。这种情况下,我们需要建立一个表,然后定义所有字段的关系。我们首先通过db_create建立一个表,然后再打开windows数据库,运行mysqldump命令查看sqlmap的数据。

这里我们打开的是表datetable_title,这里我们可以看到,所有数据都是定义好的,没有任何关系。我们来看看表title字段,默认使用了一个sqlite格式的字段,我们定义datastring="useragent"获取这个字段。因为我们要获取tags下的所有文章,所以我们需要传入一个row字段,然后传入数据。

我们新建了两个字段表datestring和datestring_array。分别使用“”表示列名。那么问题来了,在建立表和索引时,为什么只能存在一个字段?难道“*”不行吗?其实,当有多个字段时,我们需要复制字段名,再建立表和索引。我们新建mysqldump,然后运行mysqlinsert,会出现log信息,然后打开db_create.sqlmap命令,查看row返回值和data值。

如果报错了,也是因为这两个字段我们定义的name没有对应上。我们还是需要传入row字段。windows数据库打开mysqldb_create.sqlmap命令。我们首先查看mysqldump命令的输出,发现数据是file是datestring_array。但是我们不希望它输出数据,我们希望它输出tags下所有文章的信息。

我们需要把datestring_array传给mysqldb_create.sqlmap命令。mysqldb_create.sqlmap命令打开mysqldb,mysqldb_create.sqlmap命令是打开一个mysql数据库,并且还不能修改数据库。因为打开的文件不能修改。我们只能编辑文件。编辑mysqldb_create.sqlmap命令:1.我们选择第一个参数表示目标库(dbname),如下:1table_id=tab_id2tab_url='/root/data:/tabs/data/'3create_table_name=user-agent4mysql_db_info={'table_id':2,'tab_url':'/','tab_name':"。 查看全部

关键词文章采集源码(:关键词文章采集源码及配置采集前的准备)

关键词文章采集源码及配置采集前准备我们需要在写博客的时候准备好我们需要采集的文章列表,比如:找死的python与sqlmap之间的对比。针对采集某一数据源、某一文章进行采集。因为我们是自己写的采集,所以我们先需要搞定这两点。准备好我们采集的源码。编写文章采集的代码文章采集一般是带有tags标签的,tags我们可以在页面上获取到,也可以通过xpath获取到。

我们将这篇文章里的内容tags命名为“user-agent”。打开mysql的select查询,查看row返回值的值和data值。根据我们刚才获取到的返回值,我们发现。所有字段值都是我们自己定义的,与采集其他字段没有任何关系。这种情况下,我们需要建立一个表,然后定义所有字段的关系。我们首先通过db_create建立一个表,然后再打开windows数据库,运行mysqldump命令查看sqlmap的数据。

这里我们打开的是表datetable_title,这里我们可以看到,所有数据都是定义好的,没有任何关系。我们来看看表title字段,默认使用了一个sqlite格式的字段,我们定义datastring="useragent"获取这个字段。因为我们要获取tags下的所有文章,所以我们需要传入一个row字段,然后传入数据。

我们新建了两个字段表datestring和datestring_array。分别使用“”表示列名。那么问题来了,在建立表和索引时,为什么只能存在一个字段?难道“*”不行吗?其实,当有多个字段时,我们需要复制字段名,再建立表和索引。我们新建mysqldump,然后运行mysqlinsert,会出现log信息,然后打开db_create.sqlmap命令,查看row返回值和data值。

如果报错了,也是因为这两个字段我们定义的name没有对应上。我们还是需要传入row字段。windows数据库打开mysqldb_create.sqlmap命令。我们首先查看mysqldump命令的输出,发现数据是file是datestring_array。但是我们不希望它输出数据,我们希望它输出tags下所有文章的信息。

我们需要把datestring_array传给mysqldb_create.sqlmap命令。mysqldb_create.sqlmap命令打开mysqldb,mysqldb_create.sqlmap命令是打开一个mysql数据库,并且还不能修改数据库。因为打开的文件不能修改。我们只能编辑文件。编辑mysqldb_create.sqlmap命令:1.我们选择第一个参数表示目标库(dbname),如下:1table_id=tab_id2tab_url='/root/data:/tabs/data/'3create_table_name=user-agent4mysql_db_info={'table_id':2,'tab_url':'/','tab_name':"。

关键词文章采集源码(一篇文章可以优化几百关键词吗?当然可以吗)

采集交流 • 优采云 发表了文章 • 0 个评论 • 135 次浏览 • 2021-09-19 13:08

许多SEOER每天都写原创但他们的个人能力有限。他们一天不能输出很多文章。相反,那些采集伪原创的排名每天都在提高。一个文章能优化数百个关键词吗?当然今天,error blog()共享的内容是“如何使用一个文章优化数百个关键词”。我希望它能帮助你

一、关键词和网站与页面之间的关系

每个网站在不主宰屏幕的情况下,关键词理论上只在一个页面上优化,更多将导致站内竞争。想要在同一个网站的同一个关键词主屏幕上获得多个更好的排名并不容易

理论上,一个关键词只在一个页面上排列,但一个页面上可以优化多个关键词。从网站主页可以看出,大多数网站主页都有很高的权重,可以优化很多关键词

所以我们经常看到网站主页上有很多关键词的排名,排名也很好

但是如果你想用一个文章来优化多个关键词可以吗?当然可以,但是文章页面的关键词排名相对不稳定。它不如主页、专栏、主题甚至标签页好,因为它们属于文章list。此外,文章本身的权重也不太适合优化。一些文章在类似的网站中确实有很多关键词排名,但它们属于高质量电台中的少数精品店文章

二、an-article原创optimization-100关键词

上述概念基本上是指一个文章页面来优化多个关键词,而错误博客文章是关于一个原创文章来优化多个关键词@

因为一个原创文章可以修改关键词来创建多个文章,理论上,只要操作正确,这样的页面也符合搜索引擎规范。当然,有些人可能会以这种方式作弊

优化原创文章中数百个关键词的方法非常简单,即文章文章中关键词的密度非常高,只要修改这个关键词,就可以直接影响文章的相似性,得到的文章与原创相似@

当一篇高质量的原创文章文章收录大量文章和不同的关键词在同一天制作,并且所有这些页面同时提交给搜索引擎时,搜索引擎很可能会判断原创并且即使感觉到文章重复,概率也会是收录的一部分

当然,这出戏的前提是网站确实有一定程度的搜索引擎友好性,可以达到收录周或收录次日,甚至可以达到收录和收录秒。在收录大多数人都有排名后,他们可以使用这种操作方法。对于一些本身并不收录的网站,所有技能都是免费的

上面是错误博客()共享的内容是“如何用一个文章优化数百个关键词”。谢谢你的阅读。更多原创文章搜索“错误日志” 查看全部

关键词文章采集源码(一篇文章可以优化几百关键词吗?当然可以吗)

许多SEOER每天都写原创但他们的个人能力有限。他们一天不能输出很多文章。相反,那些采集伪原创的排名每天都在提高。一个文章能优化数百个关键词吗?当然今天,error blog()共享的内容是“如何使用一个文章优化数百个关键词”。我希望它能帮助你

一、关键词和网站与页面之间的关系

每个网站在不主宰屏幕的情况下,关键词理论上只在一个页面上优化,更多将导致站内竞争。想要在同一个网站的同一个关键词主屏幕上获得多个更好的排名并不容易

理论上,一个关键词只在一个页面上排列,但一个页面上可以优化多个关键词。从网站主页可以看出,大多数网站主页都有很高的权重,可以优化很多关键词

所以我们经常看到网站主页上有很多关键词的排名,排名也很好

但是如果你想用一个文章来优化多个关键词可以吗?当然可以,但是文章页面的关键词排名相对不稳定。它不如主页、专栏、主题甚至标签页好,因为它们属于文章list。此外,文章本身的权重也不太适合优化。一些文章在类似的网站中确实有很多关键词排名,但它们属于高质量电台中的少数精品店文章

二、an-article原创optimization-100关键词

上述概念基本上是指一个文章页面来优化多个关键词,而错误博客文章是关于一个原创文章来优化多个关键词@

因为一个原创文章可以修改关键词来创建多个文章,理论上,只要操作正确,这样的页面也符合搜索引擎规范。当然,有些人可能会以这种方式作弊

优化原创文章中数百个关键词的方法非常简单,即文章文章中关键词的密度非常高,只要修改这个关键词,就可以直接影响文章的相似性,得到的文章与原创相似@

当一篇高质量的原创文章文章收录大量文章和不同的关键词在同一天制作,并且所有这些页面同时提交给搜索引擎时,搜索引擎很可能会判断原创并且即使感觉到文章重复,概率也会是收录的一部分

当然,这出戏的前提是网站确实有一定程度的搜索引擎友好性,可以达到收录周或收录次日,甚至可以达到收录和收录秒。在收录大多数人都有排名后,他们可以使用这种操作方法。对于一些本身并不收录的网站,所有技能都是免费的

上面是错误博客()共享的内容是“如何用一个文章优化数百个关键词”。谢谢你的阅读。更多原创文章搜索“错误日志”

关键词文章采集源码(数据集、实现代码介绍:候选词生成(下))

采集交流 • 优采云 发表了文章 • 0 个评论 • 121 次浏览 • 2021-09-19 03:06

目录:第1部分:概述第2部分:数据集和实现代码简介第3部分:特征设计第4部分:候选词生成(I)第5部分:候选词生成(II)第6部分:性能比较

这个博客将介绍我的关键词提取系统使用的数据集和我实现的代码结构。如果读者想在阅读博客时查看数据并运行代码,这将是一个很好的指南

2.1数据集简介

本文中用于培训和测试的数据来自semeval 2017任务10。有500篇论文来自计算机科学、材料科学和物理学领域,每一篇都收录选定的段落和关键词注释信息。其中350个用作训练集,其余150个用作测试集。每篇论文的选定段落约为200字的纯文本,不包括标题和摘要等结构信息。对测试集进行简单的统计,每张试卷都标有关键词约20。可以看出,该数据集具有以下特点:文本长度较短,但标签数关键词远高于正常值,这有利于机器学习取得更好的效果。这里有两个文本截图和相应的关键词标签,可以获得直观的感觉

您可以从semeval 2017任务10的官方网站获取有关数据集的更多信息

2.2实现代码介绍

我的系统分两步实现关键词提取。Mr.首先形成候选词,然后使用分类模型在候选词上选择关键词。在候选词生成阶段,我们使用了两种方法,名词短语提取和CRF注释,并在第六章中比较了它们的性能

这里的代码SRC是在Python3中使用nltk、sklearn和其他库实现的。一些数据不包括在内,例如单词向量和训练数据

代码的内容和每个文件的含义描述如下:

根目录:

--Main.py运行文件

--Ekrsy/code文件夹

----init.py

----py实现文档和关键字类

----Feature.py实现各种功能来提取特征

----Util.py封装了一些工具和方法

----py封装了从文件中读取字向量的功能

----Test.py一些测试方法

----Log.py定义日志格式

----crf_u工具.py实现了crf++注释的数据转换,并调用模型进行注释

----py实现了提取候选词的功能

----py实现各种分类模型

----py封装文档集类

--数据/放置所使用的数据文件

----训练/训练数据集

----开发/测试数据集

----使用CRF+的CRF/CRF注释配置文件+

----外部资源/外部资源数据

------freq Wikipedia计算的英语文章词频

------IDF Wikipedia计算的反向文档频率

------IEEE文本分类表

------Glove.6b.50d.txt手套训练字向量数据

本系列文章将不介绍具体的代码细节,如果需要运行结果,代码应该很容易理解

本文文章介绍了关键词提取系统的数据集和实现代码结构。接下来,将介绍特征设计和候选词生成 查看全部

关键词文章采集源码(数据集、实现代码介绍:候选词生成(下))

目录:第1部分:概述第2部分:数据集和实现代码简介第3部分:特征设计第4部分:候选词生成(I)第5部分:候选词生成(II)第6部分:性能比较

这个博客将介绍我的关键词提取系统使用的数据集和我实现的代码结构。如果读者想在阅读博客时查看数据并运行代码,这将是一个很好的指南

2.1数据集简介

本文中用于培训和测试的数据来自semeval 2017任务10。有500篇论文来自计算机科学、材料科学和物理学领域,每一篇都收录选定的段落和关键词注释信息。其中350个用作训练集,其余150个用作测试集。每篇论文的选定段落约为200字的纯文本,不包括标题和摘要等结构信息。对测试集进行简单的统计,每张试卷都标有关键词约20。可以看出,该数据集具有以下特点:文本长度较短,但标签数关键词远高于正常值,这有利于机器学习取得更好的效果。这里有两个文本截图和相应的关键词标签,可以获得直观的感觉

您可以从semeval 2017任务10的官方网站获取有关数据集的更多信息

2.2实现代码介绍

我的系统分两步实现关键词提取。Mr.首先形成候选词,然后使用分类模型在候选词上选择关键词。在候选词生成阶段,我们使用了两种方法,名词短语提取和CRF注释,并在第六章中比较了它们的性能

这里的代码SRC是在Python3中使用nltk、sklearn和其他库实现的。一些数据不包括在内,例如单词向量和训练数据

代码的内容和每个文件的含义描述如下:

根目录:

--Main.py运行文件

--Ekrsy/code文件夹

----init.py

----py实现文档和关键字类

----Feature.py实现各种功能来提取特征

----Util.py封装了一些工具和方法

----py封装了从文件中读取字向量的功能

----Test.py一些测试方法

----Log.py定义日志格式

----crf_u工具.py实现了crf++注释的数据转换,并调用模型进行注释

----py实现了提取候选词的功能

----py实现各种分类模型

----py封装文档集类

--数据/放置所使用的数据文件

----训练/训练数据集

----开发/测试数据集

----使用CRF+的CRF/CRF注释配置文件+

----外部资源/外部资源数据

------freq Wikipedia计算的英语文章词频

------IDF Wikipedia计算的反向文档频率

------IEEE文本分类表

------Glove.6b.50d.txt手套训练字向量数据

本系列文章将不介绍具体的代码细节,如果需要运行结果,代码应该很容易理解

本文文章介绍了关键词提取系统的数据集和实现代码结构。接下来,将介绍特征设计和候选词生成

关键词文章采集源码(如何应对网络中的新闻内容也一样?系统帮你解决)

采集交流 • 优采云 发表了文章 • 0 个评论 • 97 次浏览 • 2021-09-16 20:11