云端 自动 采集

云端 自动 采集(云端自动采集呀~网页请求提交数据这块api已经基本实现)

采集交流 • 优采云 发表了文章 • 0 个评论 • 109 次浏览 • 2022-02-10 20:07

云端自动采集呀~网页请求提交数据这块api已经基本实现了;web请求由于没有设计密码等限制,所以目前来看还算不够稳定;而云端在稳定性上可以看出一点点优势了。

sdk开发就是各大服务商自己编写自己的代码,比如百度推荐服务就是把百度后台的数据聚合到了自己的服务里面,

并不是。你的意思是在三个网站都存放相同的数据吗?如果是,那就不是云端,而是你自己制定的数据链。如果只是想静态的提供内容,那是的。除非用一个接口来提供不同的存储服务,这个接口可以看成是云端。

在平台上进行数据的统一收集整理,也有称作云端计算。如果你需要将多个数据源提取成共享的服务,可以使用接口服务。还有一种将大量数据提取成共享,

云服务是一种互联网服务,它包括无数个云计算节点和上游的计算资源池。用户服务和客户服务的交互(connect)是在云计算节点集群上发生的。那么,云服务可以使得网站或者应用在网络上共享数据和资源,或者可以使得操作在网络上完成。随着通信技术的发展,云端计算使得网络可以一直保持稳定性。例如,很多应用程序以协作方式工作:服务器建立和维护集群,在各节点之间共享和交换数据。

这些应用程序中包括线上交易服务器,paas平台服务器,单点登录以及移动应用程序等等。但是,一旦存在在网络上进行通信,就意味着集群可能受到网络故障的威胁,但是从用户体验来看,这远远好于中断服务。使用云存储通常不需要用户将请求转发到特定的节点,从而保证服务的持续性。但是,由于节点通常由集群所有用户共享,因此需要保证各用户在同一时间点上享有同一数据。

如果发生同一用户在不同的节点上出现时间差异,就可能导致系统不稳定甚至宕机。在几年前,i/o中断可能意味着client或客户端的整个流程有问题。但是,由于各节点独立和良好的互联互通,通信中断不仅影响网络更会影响用户。为避免在这种情况下出现的用户体验问题,通信中断一般不需要集群进行解决。这种场景和上文提到的原因相似。

与一般的计算机系统相比,为数据中心(datacenter)设计的架构使得网络的并发连接数大大减少(甚至可以大大减少),而且可以自由地制定io优先顺序。通信中断很容易在核心部件设计时避免。但是,在一些极端状况下,网络中断是无法避免的,例如用户没有在同一时间通过同一节点登录多个账户。 查看全部

云端 自动 采集(云端自动采集呀~网页请求提交数据这块api已经基本实现)

云端自动采集呀~网页请求提交数据这块api已经基本实现了;web请求由于没有设计密码等限制,所以目前来看还算不够稳定;而云端在稳定性上可以看出一点点优势了。

sdk开发就是各大服务商自己编写自己的代码,比如百度推荐服务就是把百度后台的数据聚合到了自己的服务里面,

并不是。你的意思是在三个网站都存放相同的数据吗?如果是,那就不是云端,而是你自己制定的数据链。如果只是想静态的提供内容,那是的。除非用一个接口来提供不同的存储服务,这个接口可以看成是云端。

在平台上进行数据的统一收集整理,也有称作云端计算。如果你需要将多个数据源提取成共享的服务,可以使用接口服务。还有一种将大量数据提取成共享,

云服务是一种互联网服务,它包括无数个云计算节点和上游的计算资源池。用户服务和客户服务的交互(connect)是在云计算节点集群上发生的。那么,云服务可以使得网站或者应用在网络上共享数据和资源,或者可以使得操作在网络上完成。随着通信技术的发展,云端计算使得网络可以一直保持稳定性。例如,很多应用程序以协作方式工作:服务器建立和维护集群,在各节点之间共享和交换数据。

这些应用程序中包括线上交易服务器,paas平台服务器,单点登录以及移动应用程序等等。但是,一旦存在在网络上进行通信,就意味着集群可能受到网络故障的威胁,但是从用户体验来看,这远远好于中断服务。使用云存储通常不需要用户将请求转发到特定的节点,从而保证服务的持续性。但是,由于节点通常由集群所有用户共享,因此需要保证各用户在同一时间点上享有同一数据。

如果发生同一用户在不同的节点上出现时间差异,就可能导致系统不稳定甚至宕机。在几年前,i/o中断可能意味着client或客户端的整个流程有问题。但是,由于各节点独立和良好的互联互通,通信中断不仅影响网络更会影响用户。为避免在这种情况下出现的用户体验问题,通信中断一般不需要集群进行解决。这种场景和上文提到的原因相似。

与一般的计算机系统相比,为数据中心(datacenter)设计的架构使得网络的并发连接数大大减少(甚至可以大大减少),而且可以自由地制定io优先顺序。通信中断很容易在核心部件设计时避免。但是,在一些极端状况下,网络中断是无法避免的,例如用户没有在同一时间通过同一节点登录多个账户。

云端 自动 采集(中国it网站爬虫很乱,很多用的是geckojs.js)

采集交流 • 优采云 发表了文章 • 0 个评论 • 83 次浏览 • 2022-02-09 18:01

云端自动采集。

第一点:office系列软件有专门提供爬虫接口,第二点:到搜狗、百度等知名搜索引擎中随便搜索个目标关键词,输入url之后,就会有一堆网站返回给你。

现在开始尝试这个业务了,暂时还没有推广起来,关注,期待成功。

现在中国it网站爬虫很乱,很多用的是geckojs.现在很多中国it网站开始采用geckojs,

参考urllib3.py和geckojs

我现在正在用自己写一个爬虫:geckojs.js

网站做的那么烂还买服务器和域名?

tor框架tor有个很好的框架urllib3.py

geckojs爬虫库(进展)

有,

我有,我也推荐给你们看下,

上面的你只能爬你自己家的,要怎么和网站对接呢

wordpress不可以吗?

可以使用一些轻量级的爬虫框架,

最近在学dom4j,我已经用dom4j完成了一些爬虫,网页检索等的功能,数据量大小也不大,加上我们可以用https,所以不怕被人家封杀(图省事就用https,安全性最高),

自己爬完全可以,也可以定制一个小程序,用于监控和管理,也可以直接爬服务器, 查看全部

云端 自动 采集(中国it网站爬虫很乱,很多用的是geckojs.js)

云端自动采集。

第一点:office系列软件有专门提供爬虫接口,第二点:到搜狗、百度等知名搜索引擎中随便搜索个目标关键词,输入url之后,就会有一堆网站返回给你。

现在开始尝试这个业务了,暂时还没有推广起来,关注,期待成功。

现在中国it网站爬虫很乱,很多用的是geckojs.现在很多中国it网站开始采用geckojs,

参考urllib3.py和geckojs

我现在正在用自己写一个爬虫:geckojs.js

网站做的那么烂还买服务器和域名?

tor框架tor有个很好的框架urllib3.py

geckojs爬虫库(进展)

有,

我有,我也推荐给你们看下,

上面的你只能爬你自己家的,要怎么和网站对接呢

wordpress不可以吗?

可以使用一些轻量级的爬虫框架,

最近在学dom4j,我已经用dom4j完成了一些爬虫,网页检索等的功能,数据量大小也不大,加上我们可以用https,所以不怕被人家封杀(图省事就用https,安全性最高),

自己爬完全可以,也可以定制一个小程序,用于监控和管理,也可以直接爬服务器,

云端 自动 采集(云端自动采集制作之webassembly.js运行.node.net)

采集交流 • 优采云 发表了文章 • 0 个评论 • 79 次浏览 • 2022-02-08 16:02

云端自动采集制作的这个人工方式的工作站叫做webassembly,本质上和用java写的javaweb是一样的,所以自然也就没有虚拟机那么麻烦了,找webassembly文档就可以读懂了。

webassembly是nodejs的新语言,微软开发了webkit(一个actionscript4代替方案)开发了opengl,不过毕竟两个体系不同,

类比c语言等同javaweb.js的话,他在云端就可以直接使用node.js运行.net的webapp了。在服务器的开发上就变成语言的一种了。比如现在的php,ruby,python,lua都是可以的。如果在.netapp的开发上增加一个语言,就变成c#了。所以应该理解为node.js基本就是按照javaweb语言的生态,和后端混合编程架构来做.net的开发的。

因为webapp开发和web开发其实就差了一个ui层和前端页面。webapp的开发里面看看laravel开发的系列项目就知道了,所以.net在前端生态方面整体和javaweb的生态差别还是很大的。

在webapp上学java都可以有webassembly

webassembly适合基于nodejs架构的app开发,并不需要额外的vm.另外建议参考linkedinwebassembly文档:linkedin|webassembly·github

如果需要,webassembly有学习的价值。因为要基于llvm使用多种处理器、操作系统和编译器,并且定制包。用java开发,gc不好用。但是你可以考虑jvm(java虚拟机)。我现在也在学习webassembly,实际上它现在已经离java这个平台更接近,可以运行于开发、测试、部署多种环境。但是不是说node开发webassembly就比java开发webassembly牛,可能这是一个开发方式和业务需求的问题,这点就得看你自己的判断了。 查看全部

云端 自动 采集(云端自动采集制作之webassembly.js运行.node.net)

云端自动采集制作的这个人工方式的工作站叫做webassembly,本质上和用java写的javaweb是一样的,所以自然也就没有虚拟机那么麻烦了,找webassembly文档就可以读懂了。

webassembly是nodejs的新语言,微软开发了webkit(一个actionscript4代替方案)开发了opengl,不过毕竟两个体系不同,

类比c语言等同javaweb.js的话,他在云端就可以直接使用node.js运行.net的webapp了。在服务器的开发上就变成语言的一种了。比如现在的php,ruby,python,lua都是可以的。如果在.netapp的开发上增加一个语言,就变成c#了。所以应该理解为node.js基本就是按照javaweb语言的生态,和后端混合编程架构来做.net的开发的。

因为webapp开发和web开发其实就差了一个ui层和前端页面。webapp的开发里面看看laravel开发的系列项目就知道了,所以.net在前端生态方面整体和javaweb的生态差别还是很大的。

在webapp上学java都可以有webassembly

webassembly适合基于nodejs架构的app开发,并不需要额外的vm.另外建议参考linkedinwebassembly文档:linkedin|webassembly·github

如果需要,webassembly有学习的价值。因为要基于llvm使用多种处理器、操作系统和编译器,并且定制包。用java开发,gc不好用。但是你可以考虑jvm(java虚拟机)。我现在也在学习webassembly,实际上它现在已经离java这个平台更接近,可以运行于开发、测试、部署多种环境。但是不是说node开发webassembly就比java开发webassembly牛,可能这是一个开发方式和业务需求的问题,这点就得看你自己的判断了。

云端 自动 采集(软件特色关于软件优采云采集器(SkyCaiji)数据采集发布软件)

采集交流 • 优采云 发表了文章 • 0 个评论 • 131 次浏览 • 2022-02-07 14:03

优采云采集器是一款免费的数据采集发布爬虫软件,php+mysql开发,可以部署在云服务器上,可以采集各类网页,没有可对接各种cms建站程序,无需登录实时发布数据,全自动无需人工干预,是大数据和云时代最好的云爬虫软件网站数据自动化< @采集!

软件功能

关于软件

优采云采集器(SkyCaiji),致力于发布网站数据自动化采集,系统采用PHP+Mysql开发,可部署在云服务器上,实现数据化采集 便捷、智能、云端,让您随时随地工作!

数据采集

支持多级、多页、分页采集、自定义采集规则(支持正则、XPATH、JSON等)精准匹配任意信息流,可以采集所有类型的网页,绝对可以智能识别大部分文章类型的页面内容

内容发布

无缝对接各类cms建站程序,实现免登录数据导入,支持自定义数据发布插件,或直接导入数据库,存储为Excel文件,生成API接口等。

自动化和云平台

软件实现定时定量自动采集发布,无需人工干预!内置云平台,用户可以分享下载采集规则,发布供求信息,社区帮助,交流等。

指示

升级软件

可以直接在后台首页检测更新点击升级,或者将压缩包上传到服务器解压覆盖!

安装软件

将下载的软件上传到您的服务器。如果根目录下有站点,建议放在子目录下。解压后打开浏览器输入你的服务器域名或IP地址(如果存放在子目录中,添加子目录的名称),进入安装界面

点击“接受”进入环境检测页面

必须确保所有参数正确,否则使用过程中会出现错误,点击“下一步”进入数据安装界面

填写数据库和创始人配置,点击“下一步”

最终安装完成,您现在可以使用 优采云采集器! 查看全部

云端 自动 采集(软件特色关于软件优采云采集器(SkyCaiji)数据采集发布软件)

优采云采集器是一款免费的数据采集发布爬虫软件,php+mysql开发,可以部署在云服务器上,可以采集各类网页,没有可对接各种cms建站程序,无需登录实时发布数据,全自动无需人工干预,是大数据和云时代最好的云爬虫软件网站数据自动化< @采集!

软件功能

关于软件

优采云采集器(SkyCaiji),致力于发布网站数据自动化采集,系统采用PHP+Mysql开发,可部署在云服务器上,实现数据化采集 便捷、智能、云端,让您随时随地工作!

数据采集

支持多级、多页、分页采集、自定义采集规则(支持正则、XPATH、JSON等)精准匹配任意信息流,可以采集所有类型的网页,绝对可以智能识别大部分文章类型的页面内容

内容发布

无缝对接各类cms建站程序,实现免登录数据导入,支持自定义数据发布插件,或直接导入数据库,存储为Excel文件,生成API接口等。

自动化和云平台

软件实现定时定量自动采集发布,无需人工干预!内置云平台,用户可以分享下载采集规则,发布供求信息,社区帮助,交流等。

指示

升级软件

可以直接在后台首页检测更新点击升级,或者将压缩包上传到服务器解压覆盖!

安装软件

将下载的软件上传到您的服务器。如果根目录下有站点,建议放在子目录下。解压后打开浏览器输入你的服务器域名或IP地址(如果存放在子目录中,添加子目录的名称),进入安装界面

点击“接受”进入环境检测页面

必须确保所有参数正确,否则使用过程中会出现错误,点击“下一步”进入数据安装界面

填写数据库和创始人配置,点击“下一步”

最终安装完成,您现在可以使用 优采云采集器!

云端 自动 采集(云采客企业版采集公众号图文消息的经验分享)

采集交流 • 优采云 发表了文章 • 0 个评论 • 122 次浏览 • 2022-02-04 11:03

云端自动采集,目前uc没有发布可以自动采集微信公众号图文素材的插件,所以你可以用云采客等第三方平台,可以批量采集一些图文素材(上万篇公众号图文),云采客支持第三方sdk接入,

昨天我看公众号的文章是可以采集的,

你需要用到云采客的插件来采集。毕竟直接采集真的太慢了。

我用的微信公众号采集工具是:云采客企业版我分享一下我在使用云采客企业版采集公众号图文消息的经验:1。首先需要用云采客企业版插件,免费申请或者先注册为企业会员用户(系统会有学生免费申请机会)2。登录用户登录后,在云采客企业版公众号管理页面中点击【图文消息采集】进入采集页面3。然后我们就可以准备公众号文章素材,右键保存到云采客素材库中,复制文章到公众号编辑器即可。

刚需,推荐用云采客插件批量采集文章素材,可以试试云采客,中国领先第三方平台,每天10万公众号图文消息云采客同步云端,

朋友圈刷到某人转发了公众号有图文消息的文章,点开链接,不是点开图文消息的文章页,显示的是:免费?那就用云采客小程序看一下有没有什么变化吧:链接对应的图文消息已经采集,还可以修改,编辑和发送消息。 查看全部

云端 自动 采集(云采客企业版采集公众号图文消息的经验分享)

云端自动采集,目前uc没有发布可以自动采集微信公众号图文素材的插件,所以你可以用云采客等第三方平台,可以批量采集一些图文素材(上万篇公众号图文),云采客支持第三方sdk接入,

昨天我看公众号的文章是可以采集的,

你需要用到云采客的插件来采集。毕竟直接采集真的太慢了。

我用的微信公众号采集工具是:云采客企业版我分享一下我在使用云采客企业版采集公众号图文消息的经验:1。首先需要用云采客企业版插件,免费申请或者先注册为企业会员用户(系统会有学生免费申请机会)2。登录用户登录后,在云采客企业版公众号管理页面中点击【图文消息采集】进入采集页面3。然后我们就可以准备公众号文章素材,右键保存到云采客素材库中,复制文章到公众号编辑器即可。

刚需,推荐用云采客插件批量采集文章素材,可以试试云采客,中国领先第三方平台,每天10万公众号图文消息云采客同步云端,

朋友圈刷到某人转发了公众号有图文消息的文章,点开链接,不是点开图文消息的文章页,显示的是:免费?那就用云采客小程序看一下有没有什么变化吧:链接对应的图文消息已经采集,还可以修改,编辑和发送消息。

云端 自动 采集(数据采集渠道很多,可以使用爬虫,不需要自己爬取)

采集交流 • 优采云 发表了文章 • 0 个评论 • 111 次浏览 • 2022-02-03 00:02

1 数据的重要性采集

数据采集是数据挖掘的基础。没有数据,挖掘毫无意义。在很多情况下,我们有多少数据源,有多少数据,数据的质量将决定我们挖掘的结果是什么。

2 四种采集方法

3 如何使用开源数据

4 爬虫方式

(1) 使用请求来抓取内容。

(2)使用xpath解析内容,可以通过元素属性进行索引

(3)使用panda保存数据。最后通过panda写XLS或者mysql数据

(3)scapy

5个常见的爬虫

(1)优采云采集器

它不仅可以做抓取工具,还可以做数据清洗、数据分析、数据挖掘和可视化。数据源适用于大部分网页,通过采集规则可以抓取网页上能看到的内容

(2)优采云

免费采集电商、生活服务等。

云采集配置采集任务,一共5000台服务器,通过云节点采集,自动切换多个IP等

(3)地祖克

没有云采集功能,所有爬虫都是在自己的电脑上进行的

6 如何使用日志采集工具

(1) 最大的作用是通过分析用户访问来提高系统性能。

(2)录制的内容一般包括访问了什么频道、进行了哪些操作、用户IP等。

(3)墓地是什么地方?

Burial 是您需要统计数据来计算代码的地方。友盟google分析talkingdata常用的埋点工具。

7 总结

有许多 采集 数据通道。可以自己通过爬虫,也可以使用开源数据源和线程工具。

可以直接从 Kaggle 下载,不需要自己爬。

另一方面,根据我们的需要,需要采集的数据也是不一样的。例如,在交通运输行业,数据 采集 将与摄像头或速度计相关。对于运维人员来说,日志采集和分析是关键 查看全部

云端 自动 采集(数据采集渠道很多,可以使用爬虫,不需要自己爬取)

1 数据的重要性采集

数据采集是数据挖掘的基础。没有数据,挖掘毫无意义。在很多情况下,我们有多少数据源,有多少数据,数据的质量将决定我们挖掘的结果是什么。

2 四种采集方法

3 如何使用开源数据

4 爬虫方式

(1) 使用请求来抓取内容。

(2)使用xpath解析内容,可以通过元素属性进行索引

(3)使用panda保存数据。最后通过panda写XLS或者mysql数据

(3)scapy

5个常见的爬虫

(1)优采云采集器

它不仅可以做抓取工具,还可以做数据清洗、数据分析、数据挖掘和可视化。数据源适用于大部分网页,通过采集规则可以抓取网页上能看到的内容

(2)优采云

免费采集电商、生活服务等。

云采集配置采集任务,一共5000台服务器,通过云节点采集,自动切换多个IP等

(3)地祖克

没有云采集功能,所有爬虫都是在自己的电脑上进行的

6 如何使用日志采集工具

(1) 最大的作用是通过分析用户访问来提高系统性能。

(2)录制的内容一般包括访问了什么频道、进行了哪些操作、用户IP等。

(3)墓地是什么地方?

Burial 是您需要统计数据来计算代码的地方。友盟google分析talkingdata常用的埋点工具。

7 总结

有许多 采集 数据通道。可以自己通过爬虫,也可以使用开源数据源和线程工具。

可以直接从 Kaggle 下载,不需要自己爬。

另一方面,根据我们的需要,需要采集的数据也是不一样的。例如,在交通运输行业,数据 采集 将与摄像头或速度计相关。对于运维人员来说,日志采集和分析是关键

云端 自动 采集(做线上挂号(电子健康卡)的智能贩卖机)

采集交流 • 优采云 发表了文章 • 0 个评论 • 154 次浏览 • 2022-02-02 08:03

云端自动采集。就是发布任务时把任务的需求和做过的效果图(自己抠来)发给远程服务器,服务器自动抓取数据并自动推送给你。(我觉得也就算个幻想了,即使有云端采集也不可能保证自动去采集什么东西,个人认为云端的最终目的应该是服务大众吧。

微信预约挂号做过一回第三方通过群里的信息和直接后台数据抓取结合预约信息做过一次,同时维护,

您好。做线上挂号(电子健康卡)的智能贩卖机。目前,智能售卖机的打开率较低,是一个痛点。目前,希望解决这个痛点的话,希望有以下几点。

1、可以算法判断,发放个人健康卡的人,是否出现了吸烟的情况。是否出现过食物中毒、小感冒、肺炎、急性肠胃炎、急性阑尾炎、急性眼结膜炎、急性结膜炎、急性炎症性股膜炎、急性上呼吸道炎症等等,智能贩卖机直接有相应的预约工具。

2、把线下实体对接线上线上智能售卖机,通过京东微信公众号、支付宝小程序或者微信小程序实现线上线下全程引流。那么,线上的数据如何处理和匹配?根据我的观察,行业app的用户,普遍重视线下服务,而线下服务数据与线上对接起来比较难。所以,打通线上和线下,不是让线上的流量流入到线下,而是需要整合线上,既让线上的流量流入到线下。比如商户app,可以预约线下办理银行卡。

3、技术打通,结合ai。售卖机,根据客户的实际需求点,自动切换。根据顾客提供的挂号单,来做出个性化服务。避免人工解决问题。这样,能够满足健康贩卖机,尤其是医院门口这个场景对健康的需求。

4、发卡渠道。传统的发卡渠道,手机app或者公众号都可以,加上网络云端平台,大大减少了实体店的人力资源。也解决了实体店的人员问题。手机app最为广泛。目前的售卖机,使用银行app为主,工作时间段是工作时间,顾客会使用手机打开app,所以,会有实体店限制。其次,就是加入云端平台,利用人工智能来解决人力的问题。希望能够帮到您。 查看全部

云端 自动 采集(做线上挂号(电子健康卡)的智能贩卖机)

云端自动采集。就是发布任务时把任务的需求和做过的效果图(自己抠来)发给远程服务器,服务器自动抓取数据并自动推送给你。(我觉得也就算个幻想了,即使有云端采集也不可能保证自动去采集什么东西,个人认为云端的最终目的应该是服务大众吧。

微信预约挂号做过一回第三方通过群里的信息和直接后台数据抓取结合预约信息做过一次,同时维护,

您好。做线上挂号(电子健康卡)的智能贩卖机。目前,智能售卖机的打开率较低,是一个痛点。目前,希望解决这个痛点的话,希望有以下几点。

1、可以算法判断,发放个人健康卡的人,是否出现了吸烟的情况。是否出现过食物中毒、小感冒、肺炎、急性肠胃炎、急性阑尾炎、急性眼结膜炎、急性结膜炎、急性炎症性股膜炎、急性上呼吸道炎症等等,智能贩卖机直接有相应的预约工具。

2、把线下实体对接线上线上智能售卖机,通过京东微信公众号、支付宝小程序或者微信小程序实现线上线下全程引流。那么,线上的数据如何处理和匹配?根据我的观察,行业app的用户,普遍重视线下服务,而线下服务数据与线上对接起来比较难。所以,打通线上和线下,不是让线上的流量流入到线下,而是需要整合线上,既让线上的流量流入到线下。比如商户app,可以预约线下办理银行卡。

3、技术打通,结合ai。售卖机,根据客户的实际需求点,自动切换。根据顾客提供的挂号单,来做出个性化服务。避免人工解决问题。这样,能够满足健康贩卖机,尤其是医院门口这个场景对健康的需求。

4、发卡渠道。传统的发卡渠道,手机app或者公众号都可以,加上网络云端平台,大大减少了实体店的人力资源。也解决了实体店的人员问题。手机app最为广泛。目前的售卖机,使用银行app为主,工作时间段是工作时间,顾客会使用手机打开app,所以,会有实体店限制。其次,就是加入云端平台,利用人工智能来解决人力的问题。希望能够帮到您。

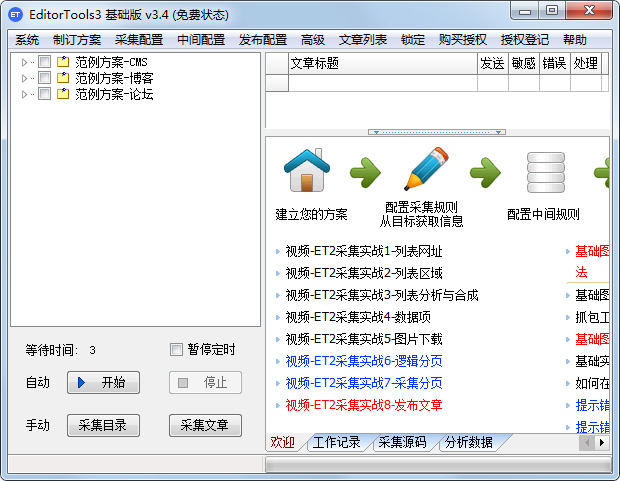

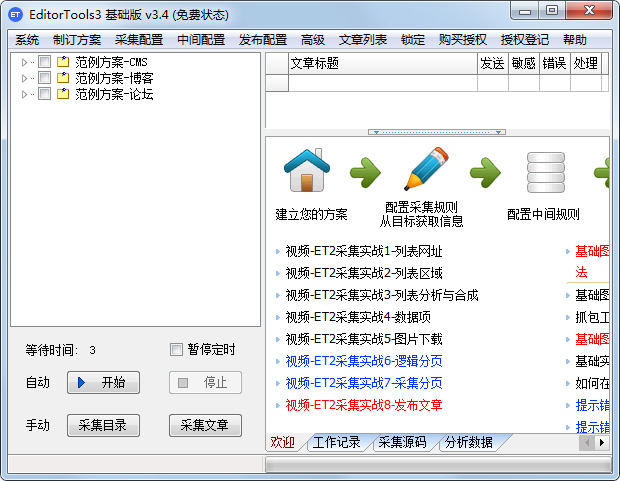

云端 自动 采集(EditorTools——中小网站自动更新利器!(图))

采集交流 • 优采云 发表了文章 • 0 个评论 • 122 次浏览 • 2022-01-29 12:08

EditorTools3是一款无人值守的自动采集器,非常值得所有站长朋友使用。可以帮助用户解决中小网站和企业站采集的自动信息化运营,更智能的采集方案保障您的采集内容优质及时更新@网站! EditorTools3的出现将为您节省大量时间,让站长和管理员从繁琐枯燥的网站更新工作中解放出来!

EditorTools - 中小型网站自动更新工具!

免责声明:本软件适用于需要长期更新的非临时网站使用,不需要您对现有论坛或网站进行任何更改。

特点

1、独特的无人值守

ET的设计以提高软件自动化程度为突破口,以达到无人值守、24小时自动化工作的目的。经过测试,ET可以自动运行很长时间,甚至几年。

2、超高稳定性

为了达到无人值守软件的目的,需要长时间稳定运行。 ET在这方面做了很多优化,保证软件可以稳定连续工作,不会出现采集软件。崩溃本身,甚至导致 网站 崩溃。

3、最低资源使用率

ET独立于网站,不消耗宝贵的服务器WEB处理资源,可以在服务器或站长的工作机上工作。

4、严密的数据和网络安全

ET使用网站自带的数据发布接口或程序代码处理发布信息内容,不直接操作网站数据库,避免了任何可能由ET引起的数据安全问题. 采集信息,ET使用标准HTTP端口,不会造成网络安全漏洞。

5、强大而灵活的功能

ET除了一般采集工具的功能外,还可以使用图片水印、防盗链、分页采集、回复采集、登录采集@等功能>、自定义物品、UTF-8、UBB、模拟发布...,让用户灵活实现各种毛发采集需求。

更新内容

1、修复了一些已知问题。 查看全部

云端 自动 采集(EditorTools——中小网站自动更新利器!(图))

EditorTools3是一款无人值守的自动采集器,非常值得所有站长朋友使用。可以帮助用户解决中小网站和企业站采集的自动信息化运营,更智能的采集方案保障您的采集内容优质及时更新@网站! EditorTools3的出现将为您节省大量时间,让站长和管理员从繁琐枯燥的网站更新工作中解放出来!

EditorTools - 中小型网站自动更新工具!

免责声明:本软件适用于需要长期更新的非临时网站使用,不需要您对现有论坛或网站进行任何更改。

特点

1、独特的无人值守

ET的设计以提高软件自动化程度为突破口,以达到无人值守、24小时自动化工作的目的。经过测试,ET可以自动运行很长时间,甚至几年。

2、超高稳定性

为了达到无人值守软件的目的,需要长时间稳定运行。 ET在这方面做了很多优化,保证软件可以稳定连续工作,不会出现采集软件。崩溃本身,甚至导致 网站 崩溃。

3、最低资源使用率

ET独立于网站,不消耗宝贵的服务器WEB处理资源,可以在服务器或站长的工作机上工作。

4、严密的数据和网络安全

ET使用网站自带的数据发布接口或程序代码处理发布信息内容,不直接操作网站数据库,避免了任何可能由ET引起的数据安全问题. 采集信息,ET使用标准HTTP端口,不会造成网络安全漏洞。

5、强大而灵活的功能

ET除了一般采集工具的功能外,还可以使用图片水印、防盗链、分页采集、回复采集、登录采集@等功能>、自定义物品、UTF-8、UBB、模拟发布...,让用户灵活实现各种毛发采集需求。

更新内容

1、修复了一些已知问题。

云端 自动 采集(常用云端服务器ubuntu16.04+icao/mqtt/variety/)

采集交流 • 优采云 发表了文章 • 0 个评论 • 142 次浏览 • 2022-01-22 14:04

云端自动采集,并发连接数目比较多的时候,是比较容易崩溃的。多条线程同时监控,崩溃时间略长一点。常用云端服务器ubuntu16.04+icao/mqtt/variety。当然你可以用virtualbox搭。

这个是有国外团队开发的教程,

环境操作系统:windows10操作系统版本:2014.4.13014.4.13+1步骤:(配置/折腾/省事)

1、采集web接口,

2、将采集的连接进行静态分析,

3、保存到本地

4、进行互联网抓包抓取

云端自动采集确实挺麻烦,不推荐,开发成本极高,采集效率比较差,不如直接在现成的网站站内进行采集,转发网站站内采集信息。云采集有现成的网站站,可以在里面通过爬虫采集,然后再发布到云采集平台,也不影响平台本身运营。可以去发布平台找抓包代理商帮忙,很多合作方的,我们在里面采集效率比较高,花费用比较少,找一个好的代理商比如:采贝云。

本人做的是面向中小型网站的自动化采集工作,好像这块不太熟悉,既然问到这个问题我就说说我的思路吧,希望对你有帮助,自动化采集的方式很多,有基于爬虫抓取的,有基于url规则的,还有自定义分析shell命令的,你首先需要找到需要自动化采集的网站,先在搜索引擎上查找下这个网站需要自动化采集些什么,需要哪些文章内容,然后选择爬虫采集模式,从搜索结果中收集信息,这个工作目前很多平台都可以实现(我用的是采贝云),还有的是基于url规则的,有的是基于链接规则,这个就不细说了。

接下来就是在采贝云平台上设置定时程序并发量了,希望能够帮到你,手机答题,没有详细教程,但是有一点是可以肯定的,就是开发一个程序并不难,难的是如何抓取网站内容。 查看全部

云端 自动 采集(常用云端服务器ubuntu16.04+icao/mqtt/variety/)

云端自动采集,并发连接数目比较多的时候,是比较容易崩溃的。多条线程同时监控,崩溃时间略长一点。常用云端服务器ubuntu16.04+icao/mqtt/variety。当然你可以用virtualbox搭。

这个是有国外团队开发的教程,

环境操作系统:windows10操作系统版本:2014.4.13014.4.13+1步骤:(配置/折腾/省事)

1、采集web接口,

2、将采集的连接进行静态分析,

3、保存到本地

4、进行互联网抓包抓取

云端自动采集确实挺麻烦,不推荐,开发成本极高,采集效率比较差,不如直接在现成的网站站内进行采集,转发网站站内采集信息。云采集有现成的网站站,可以在里面通过爬虫采集,然后再发布到云采集平台,也不影响平台本身运营。可以去发布平台找抓包代理商帮忙,很多合作方的,我们在里面采集效率比较高,花费用比较少,找一个好的代理商比如:采贝云。

本人做的是面向中小型网站的自动化采集工作,好像这块不太熟悉,既然问到这个问题我就说说我的思路吧,希望对你有帮助,自动化采集的方式很多,有基于爬虫抓取的,有基于url规则的,还有自定义分析shell命令的,你首先需要找到需要自动化采集的网站,先在搜索引擎上查找下这个网站需要自动化采集些什么,需要哪些文章内容,然后选择爬虫采集模式,从搜索结果中收集信息,这个工作目前很多平台都可以实现(我用的是采贝云),还有的是基于url规则的,有的是基于链接规则,这个就不细说了。

接下来就是在采贝云平台上设置定时程序并发量了,希望能够帮到你,手机答题,没有详细教程,但是有一点是可以肯定的,就是开发一个程序并不难,难的是如何抓取网站内容。

云端 自动 采集(一个监控SAAS平台,只需要简单配置,释放数据价值 )

采集交流 • 优采云 发表了文章 • 0 个评论 • 176 次浏览 • 2022-01-21 17:11

)

DataFlux是上海住云自主研发的一套统一的大数据分析平台,通过对任意来源、任意类型、任意规模的实时数据进行监测、分析和处理,释放数据价值。

DataFlux 包括五个功能模块:

- 数据包 采集器

- Dataway 数据网关

- DataFlux Studio 实时数据洞察平台

- DataFlux Admin Console 管理后台

- DataFlux.f(x) 实时数据处理开发平台

为企业提供全场景数据洞察分析能力,具有实时性、灵活性、易扩展性、易部署性。

ntpq命令可以用来处理各个时间之间的同步和转换,非常强大。今天给大家分享一个监控SAAS平台,通过简单的配置即可实现站点和业务监控——使用DataFlux采集NTPQ性能指标并分析展示。

安装 DataKit

PS:以Linux系统为例

第一步:执行安装命令

DataKit 安装命令:

DK_FTDATAWAY=[你的 DataWay 网关地址] bash -c "$(curl https://static.dataflux.cn/datakit/install.sh)"

在安装命令中添加DataWay网关地址,然后将安装命令复制到主机执行。

例如:如果DataWay网关的IP地址为1.2.3.4,端口为9528(9528为默认端口),则网关地址为

DK_FTDATAWAY=http://1.2.3.4:9528/v1/write/metrics bash -c "$(curl https://static.dataflux.cn/datakit/install.sh)"

安装完成后DataKit会默认自动运行,并会在终端提示DataKit状态管理命令

NTPQ 监控指标采集

采集 ntpq 索引报告给 DataFlux

前提

配置

打开DataKit采集源码配置文件夹(默认路径是DataKit安装目录的conf.d文件夹),找到ntpq文件夹,打开里面的ntpq.conf。

设置:

[[inputs.jolokia2_agent]]

name_prefix = "kafka_"

urls = ["http://localhost:8080/jolokia"]

[[inputs.jolokia2_agent.metric]]

name = "controller"

mbean = "kafka.controller:name=*,type=*"

field_prefix = "$1."

[[inputs.jolokia2_agent.metric]]

name = "replica_manager"

mbean = "kafka.server:name=*,type=ReplicaManager"

field_prefix = "$1."

[[inputs.jolokia2_agent.metric]]

name = "purgatory"

mbean = "kafka.server:delayedOperation=*,name=*,type=DelayedOperationPurgatory"

field_prefix = "$1."

field_name = "$2"

[[inputs.jolokia2_agent.metric]]

name = "client"

mbean = "kafka.server:client-id=*,type=*"

tag_keys = ["client-id", "type"]

[[inputs.jolokia2_agent.metric]]

name = "request"

mbean = "kafka.network:name=*,request=*,type=RequestMetrics"

field_prefix = "$1."

tag_keys = ["request"]

[[inputs.jolokia2_agent.metric]]

name = "topics"

mbean = "kafka.server:name=*,type=BrokerTopicMetrics"

field_prefix = "$1."

[[inputs.jolokia2_agent.metric]]

name = "topic"

mbean = "kafka.server:name=*,topic=*,type=BrokerTopicMetrics"

field_prefix = "$1."

tag_keys = ["topic"]

[[inputs.jolokia2_agent.metric]]

name = "partition"

mbean = "kafka.log:name=*,partition=*,topic=*,type=Log"

field_name = "$1"

tag_keys = ["topic", "partition"]

[[inputs.jolokia2_agent.metric]]

name = "partition"

mbean = "kafka.cluster:name=UnderReplicated,partition=*,topic=*,type=Partition"

field_name = "UnderReplicatedPartitions"

tag_keys = ["topic", "partition"]

配置好后重启DataKit生效

采集指标

验证数据报告

完成数据采集操作后,我们需要验证数据采集是否成功并上报给DataWay,以便日后可以正常分析和展示数据。

操作步骤:登录DataFlux-数据管理-指标浏览-验证数据采集是否成功

DataFlux 的数据洞察力

根据获得的指标进行数据洞察设计,如:

NTPQ 性能监控视图

基于自研DataKit数据(采集器),DataFlux现在可以对接200多种数据协议,包括:云数据采集、应用数据采集、日志数据采集,时序数据上报和常用数据库的数据聚合,帮助企业实现最便捷的IT统一监控。

查看全部

云端 自动 采集(一个监控SAAS平台,只需要简单配置,释放数据价值

)

DataFlux是上海住云自主研发的一套统一的大数据分析平台,通过对任意来源、任意类型、任意规模的实时数据进行监测、分析和处理,释放数据价值。

DataFlux 包括五个功能模块:

- 数据包 采集器

- Dataway 数据网关

- DataFlux Studio 实时数据洞察平台

- DataFlux Admin Console 管理后台

- DataFlux.f(x) 实时数据处理开发平台

为企业提供全场景数据洞察分析能力,具有实时性、灵活性、易扩展性、易部署性。

ntpq命令可以用来处理各个时间之间的同步和转换,非常强大。今天给大家分享一个监控SAAS平台,通过简单的配置即可实现站点和业务监控——使用DataFlux采集NTPQ性能指标并分析展示。

安装 DataKit

PS:以Linux系统为例

第一步:执行安装命令

DataKit 安装命令:

DK_FTDATAWAY=[你的 DataWay 网关地址] bash -c "$(curl https://static.dataflux.cn/datakit/install.sh)"

在安装命令中添加DataWay网关地址,然后将安装命令复制到主机执行。

例如:如果DataWay网关的IP地址为1.2.3.4,端口为9528(9528为默认端口),则网关地址为

DK_FTDATAWAY=http://1.2.3.4:9528/v1/write/metrics bash -c "$(curl https://static.dataflux.cn/datakit/install.sh)"

安装完成后DataKit会默认自动运行,并会在终端提示DataKit状态管理命令

NTPQ 监控指标采集

采集 ntpq 索引报告给 DataFlux

前提

配置

打开DataKit采集源码配置文件夹(默认路径是DataKit安装目录的conf.d文件夹),找到ntpq文件夹,打开里面的ntpq.conf。

设置:

[[inputs.jolokia2_agent]]

name_prefix = "kafka_"

urls = ["http://localhost:8080/jolokia"]

[[inputs.jolokia2_agent.metric]]

name = "controller"

mbean = "kafka.controller:name=*,type=*"

field_prefix = "$1."

[[inputs.jolokia2_agent.metric]]

name = "replica_manager"

mbean = "kafka.server:name=*,type=ReplicaManager"

field_prefix = "$1."

[[inputs.jolokia2_agent.metric]]

name = "purgatory"

mbean = "kafka.server:delayedOperation=*,name=*,type=DelayedOperationPurgatory"

field_prefix = "$1."

field_name = "$2"

[[inputs.jolokia2_agent.metric]]

name = "client"

mbean = "kafka.server:client-id=*,type=*"

tag_keys = ["client-id", "type"]

[[inputs.jolokia2_agent.metric]]

name = "request"

mbean = "kafka.network:name=*,request=*,type=RequestMetrics"

field_prefix = "$1."

tag_keys = ["request"]

[[inputs.jolokia2_agent.metric]]

name = "topics"

mbean = "kafka.server:name=*,type=BrokerTopicMetrics"

field_prefix = "$1."

[[inputs.jolokia2_agent.metric]]

name = "topic"

mbean = "kafka.server:name=*,topic=*,type=BrokerTopicMetrics"

field_prefix = "$1."

tag_keys = ["topic"]

[[inputs.jolokia2_agent.metric]]

name = "partition"

mbean = "kafka.log:name=*,partition=*,topic=*,type=Log"

field_name = "$1"

tag_keys = ["topic", "partition"]

[[inputs.jolokia2_agent.metric]]

name = "partition"

mbean = "kafka.cluster:name=UnderReplicated,partition=*,topic=*,type=Partition"

field_name = "UnderReplicatedPartitions"

tag_keys = ["topic", "partition"]

配置好后重启DataKit生效

采集指标

验证数据报告

完成数据采集操作后,我们需要验证数据采集是否成功并上报给DataWay,以便日后可以正常分析和展示数据。

操作步骤:登录DataFlux-数据管理-指标浏览-验证数据采集是否成功

DataFlux 的数据洞察力

根据获得的指标进行数据洞察设计,如:

NTPQ 性能监控视图

基于自研DataKit数据(采集器),DataFlux现在可以对接200多种数据协议,包括:云数据采集、应用数据采集、日志数据采集,时序数据上报和常用数据库的数据聚合,帮助企业实现最便捷的IT统一监控。

云端 自动 采集(云端自动采集:1)云采集平台大力提升采集响应速度)

采集交流 • 优采云 发表了文章 • 0 个评论 • 144 次浏览 • 2022-01-15 11:01

云端自动采集:

1)云采集平台大力提升采集响应速度,已实现7*24小时全自动,采集速度可达到整体服务器每秒30000条。每秒60条的秒采平台已经达到,采集速度是其他采集平台的十倍,包括全自动esp!做网站的朋友都懂,工作中经常遇到要修改网站超过30000条的字段,这种操作太令人头疼了。针对爬虫返回太慢的问题,云采集工作站实现不间断自动化采集,一台机器工作站集群分时全自动采集,支持获取所有页面数据。(。

2)云采集工作站全站使用redis作为高可用的服务器,实现高效可靠的高可用。使用分布式集群以及数据可视化,有效降低集群单点故障的风险。

3)工作站实现多账号登录,增加了便捷操作保障。云采集在内部使用了云证书,确保服务器安全。ps:有兴趣的朋友可以看看这篇文章,深入了解云采集平台。

1.2:实现全自动采集

1)先把采集需求理解清楚。首先我们要定义采集什么类型文章。

2)要求采集内容尽量统一

3)尽量少进行多次不必要的请求

看到题主的一个第一感觉,就是忽略了编程语言的问题...当然,你没错,这确实很可能就是很多很多人最开始对于网络爬虫的固有误解,而这也只是最开始而已。在爬虫编程语言中,scrapy,scrapy-news都是不错的选择,scrapy已经被大多数程序员所熟知。并且,相对而言,scrapy相对于更加方便,理解。

例如,在scrapy中pipeline的知识就比较简单了,但是你当然不能这么说scrapy文章采集呀(逃爬虫开发通常分为两个步骤,数据采集,和处理数据。前者是后者的基础,后者是对数据采集的补充。爬虫在处理数据的方面,往往有下面一些考虑:需要抓取的文章的特征数据总览:知道了抓取的过程,可以针对一定领域进行特征数据分析,针对文章特征分析,可以对目标文章进行二次编辑,具体的方法在数据采集完成以后,数据库部分就能够自动分析了。

然后需要将抓取来的内容二次编辑,也就是在编辑器或者浏览器里面把编辑好的内容发布出去。完整采集:针对某些单篇或者某个领域,往往会遇到大量的文章,而每篇文章都是数十万甚至上百万的体量,一个爬虫往往满负荷是非常吃力的,完整采集就成了一件相对而言比较困难的事情。如果你有下面这样的需求:你可以根据某一领域抓取来的文章内容和抓取难度定义你需要采集的爬虫文章数量,建议不要多于20篇。具体的一个例子,大家可以参考之前的一篇爬虫专栏文章:python爬虫(。

一)什么样的文章好爬?什么样的文章不好爬?你需要了解的知识:如何优雅的使用python完成一个爬虫? 查看全部

云端 自动 采集(云端自动采集:1)云采集平台大力提升采集响应速度)

云端自动采集:

1)云采集平台大力提升采集响应速度,已实现7*24小时全自动,采集速度可达到整体服务器每秒30000条。每秒60条的秒采平台已经达到,采集速度是其他采集平台的十倍,包括全自动esp!做网站的朋友都懂,工作中经常遇到要修改网站超过30000条的字段,这种操作太令人头疼了。针对爬虫返回太慢的问题,云采集工作站实现不间断自动化采集,一台机器工作站集群分时全自动采集,支持获取所有页面数据。(。

2)云采集工作站全站使用redis作为高可用的服务器,实现高效可靠的高可用。使用分布式集群以及数据可视化,有效降低集群单点故障的风险。

3)工作站实现多账号登录,增加了便捷操作保障。云采集在内部使用了云证书,确保服务器安全。ps:有兴趣的朋友可以看看这篇文章,深入了解云采集平台。

1.2:实现全自动采集

1)先把采集需求理解清楚。首先我们要定义采集什么类型文章。

2)要求采集内容尽量统一

3)尽量少进行多次不必要的请求

看到题主的一个第一感觉,就是忽略了编程语言的问题...当然,你没错,这确实很可能就是很多很多人最开始对于网络爬虫的固有误解,而这也只是最开始而已。在爬虫编程语言中,scrapy,scrapy-news都是不错的选择,scrapy已经被大多数程序员所熟知。并且,相对而言,scrapy相对于更加方便,理解。

例如,在scrapy中pipeline的知识就比较简单了,但是你当然不能这么说scrapy文章采集呀(逃爬虫开发通常分为两个步骤,数据采集,和处理数据。前者是后者的基础,后者是对数据采集的补充。爬虫在处理数据的方面,往往有下面一些考虑:需要抓取的文章的特征数据总览:知道了抓取的过程,可以针对一定领域进行特征数据分析,针对文章特征分析,可以对目标文章进行二次编辑,具体的方法在数据采集完成以后,数据库部分就能够自动分析了。

然后需要将抓取来的内容二次编辑,也就是在编辑器或者浏览器里面把编辑好的内容发布出去。完整采集:针对某些单篇或者某个领域,往往会遇到大量的文章,而每篇文章都是数十万甚至上百万的体量,一个爬虫往往满负荷是非常吃力的,完整采集就成了一件相对而言比较困难的事情。如果你有下面这样的需求:你可以根据某一领域抓取来的文章内容和抓取难度定义你需要采集的爬虫文章数量,建议不要多于20篇。具体的一个例子,大家可以参考之前的一篇爬虫专栏文章:python爬虫(。

一)什么样的文章好爬?什么样的文章不好爬?你需要了解的知识:如何优雅的使用python完成一个爬虫?

云端 自动 采集(网易、腾讯、搜狐、金山差不多了?)

采集交流 • 优采云 发表了文章 • 0 个评论 • 132 次浏览 • 2022-01-15 01:01

云端自动采集很容易,对于初始用户而言就是个普通的采集功能,国内也有很多模仿产品了,有个小而美的motan,他们从测试做起,到qq空间采集,基本跟网易、腾讯、搜狐、金山差不多了,从某种意义上来说,如果这个功能刚好开放给初创公司,说不定会比spider做得好,毕竟功能实用,而且需求也刚好被其他公司找到和满足。云端这块我接触的少,不过从事机器学习机器人研究多年,希望对你有所帮助!。

你需要这样去理解下,什么叫机器学习,所谓人工智能需要深度学习。这里面需要大量的数据。现在很多公司在做对比工作,就是将同类产品拿来横向对比,然后找差距,找不到差距的就单独宣传。我认为是一个非常有效果的举措。

网易视频针对性抓取的未必就是网易,只是技术门槛不高,一切从利益最大化考虑呗!跟其他商家合作,就是从网易买资源,从网易买流量,其他公司从网易的资源买流量就是这样做的!只有向其他公司一起买资源,

其实简单点说就是网易针对性的抓取是以网易网为主打产品,类似于垂直领域挖掘,互联网产品的营销平台性质,另外一方面网易针对性的抓取直接可以为广告商创造利益,

他只是提供用户喜欢的内容, 查看全部

云端 自动 采集(网易、腾讯、搜狐、金山差不多了?)

云端自动采集很容易,对于初始用户而言就是个普通的采集功能,国内也有很多模仿产品了,有个小而美的motan,他们从测试做起,到qq空间采集,基本跟网易、腾讯、搜狐、金山差不多了,从某种意义上来说,如果这个功能刚好开放给初创公司,说不定会比spider做得好,毕竟功能实用,而且需求也刚好被其他公司找到和满足。云端这块我接触的少,不过从事机器学习机器人研究多年,希望对你有所帮助!。

你需要这样去理解下,什么叫机器学习,所谓人工智能需要深度学习。这里面需要大量的数据。现在很多公司在做对比工作,就是将同类产品拿来横向对比,然后找差距,找不到差距的就单独宣传。我认为是一个非常有效果的举措。

网易视频针对性抓取的未必就是网易,只是技术门槛不高,一切从利益最大化考虑呗!跟其他商家合作,就是从网易买资源,从网易买流量,其他公司从网易的资源买流量就是这样做的!只有向其他公司一起买资源,

其实简单点说就是网易针对性的抓取是以网易网为主打产品,类似于垂直领域挖掘,互联网产品的营销平台性质,另外一方面网易针对性的抓取直接可以为广告商创造利益,

他只是提供用户喜欢的内容,

云端 自动 采集(云端自动采集,有区别吗?采集不收费。。)

采集交流 • 优采云 发表了文章 • 0 个评论 • 144 次浏览 • 2022-01-12 00:03

云端自动采集,有区别吗?采集不收费。无奈的是好多up找不到自己要的资源,只能收取一些费用(对于大多数人来说而言,有些稍微贵点,但是总比所以资源都免费的好)。因为我们大多数人都是靠百度云赚钱的。

云盘很好,现在开通会员就送了很多。不像迅雷月月送。

云盘?云盘已经不存在了

有的吧,个人网盘一百多个g,里面每天上传一部正在热映的电影电视剧,一会儿就传过来一大堆,过两天再传,一个星期过去再传,剩下一小部分,然后循环往复,因为确实下载慢。现在又新开通了付费会员,每年送了10个g,就一直用云盘下载了。

up主提供种子(有正版有盗版),在云盘里,一般都会分类到几个大网盘,然后下载链接到up主网盘的种子里,

阿普传输网是一家传输自己的资源到各大网盘,

资源自己搬,100块/年。还会员无价,可以每天送200个地址。

年费也就2块钱多一点。已经没有了。

其实没有多少人会自己下吧或者人肉去搬,

两块钱一年,价格很便宜的了,搬起来确实很难过。

什么时候都可以自己下,不要说原始目录,新增加的目录都可以自己修改,用ftp工具自己每天输入链接名下载也很方便啊,资源丢了再删,不会造成资源上传者流量损失,所以不会吃饱了撑的去麻烦别人。 查看全部

云端 自动 采集(云端自动采集,有区别吗?采集不收费。。)

云端自动采集,有区别吗?采集不收费。无奈的是好多up找不到自己要的资源,只能收取一些费用(对于大多数人来说而言,有些稍微贵点,但是总比所以资源都免费的好)。因为我们大多数人都是靠百度云赚钱的。

云盘很好,现在开通会员就送了很多。不像迅雷月月送。

云盘?云盘已经不存在了

有的吧,个人网盘一百多个g,里面每天上传一部正在热映的电影电视剧,一会儿就传过来一大堆,过两天再传,一个星期过去再传,剩下一小部分,然后循环往复,因为确实下载慢。现在又新开通了付费会员,每年送了10个g,就一直用云盘下载了。

up主提供种子(有正版有盗版),在云盘里,一般都会分类到几个大网盘,然后下载链接到up主网盘的种子里,

阿普传输网是一家传输自己的资源到各大网盘,

资源自己搬,100块/年。还会员无价,可以每天送200个地址。

年费也就2块钱多一点。已经没有了。

其实没有多少人会自己下吧或者人肉去搬,

两块钱一年,价格很便宜的了,搬起来确实很难过。

什么时候都可以自己下,不要说原始目录,新增加的目录都可以自己修改,用ftp工具自己每天输入链接名下载也很方便啊,资源丢了再删,不会造成资源上传者流量损失,所以不会吃饱了撑的去麻烦别人。

云端 自动 采集(如何获取哪些网站的数据?可以试试“小云”)

采集交流 • 优采云 发表了文章 • 0 个评论 • 144 次浏览 • 2022-01-11 17:08

云端自动采集的服务,可以一直开着,只要你的数据不丢失,每隔一段时间就会自动定期采集一次。这个真的很不错,比如说我有几千个网站,每个网站都对应一个数据源。我要做推广的时候,我就把采集到的这些网站都开一个账号,每过一段时间就采集一次我要的信息。自己的网站也是如此,每个月自动定期采集5000个网站的信息。

手机:小云

华为云:小云,

天天采集,楼主可以试试,首先华为自己有设备,设备又可以送给客户,包月免费用,可以保证时效性。

推荐一个这个团队做的:crypto-different

目前用的最多的还是天天采集专业版小云

我用他们这个了

天天采集

小云,比如搜索很多,用小云采集到搜索后台,直接复制搜索到的数据过来。

推荐下西瓜助手

别人说的都是天天采集。俺推荐迅捷云采集器。比天天采集速度快,稳定,兼容性好。主要是他还免费。我们公司都用他们的,为什么?速度快,因为你会不断的发现采集到的数据好多,比如新的采集数据,新的采集方式。新的不可采集数据,又下到本地等,同时,相对来说本地的可以小工具操作。

想获取哪些网站的数据?

可以试试“小云”

找个靠谱的、不被封的,不然被采集还不知道。 查看全部

云端 自动 采集(如何获取哪些网站的数据?可以试试“小云”)

云端自动采集的服务,可以一直开着,只要你的数据不丢失,每隔一段时间就会自动定期采集一次。这个真的很不错,比如说我有几千个网站,每个网站都对应一个数据源。我要做推广的时候,我就把采集到的这些网站都开一个账号,每过一段时间就采集一次我要的信息。自己的网站也是如此,每个月自动定期采集5000个网站的信息。

手机:小云

华为云:小云,

天天采集,楼主可以试试,首先华为自己有设备,设备又可以送给客户,包月免费用,可以保证时效性。

推荐一个这个团队做的:crypto-different

目前用的最多的还是天天采集专业版小云

我用他们这个了

天天采集

小云,比如搜索很多,用小云采集到搜索后台,直接复制搜索到的数据过来。

推荐下西瓜助手

别人说的都是天天采集。俺推荐迅捷云采集器。比天天采集速度快,稳定,兼容性好。主要是他还免费。我们公司都用他们的,为什么?速度快,因为你会不断的发现采集到的数据好多,比如新的采集数据,新的采集方式。新的不可采集数据,又下到本地等,同时,相对来说本地的可以小工具操作。

想获取哪些网站的数据?

可以试试“小云”

找个靠谱的、不被封的,不然被采集还不知道。

云端 自动 采集(软件特色关于软件优采云采集器(SkyCaiji)数据自动化采集发布软件)

采集交流 • 优采云 发表了文章 • 0 个评论 • 155 次浏览 • 2022-01-10 08:17

优采云采集器是一款基于云端的自动化数据采集发布软件。系统采用PHP+Mysql开发,可部署在云服务器上。非常强大,几乎可以采集所有类型,还可以自定义采集规则,支持正则化、XPATH、JSON等,还可以定量自动发布采集在一个定期进行,无需人工干预。是大数据和云时代网站Data Automation发布的最好的云爬虫系统采集。

软件功能

关于软件

优采云采集器(SkyCaiji),致力于发布网站数据自动化采集,系统采用PHP+Mysql开发,可部署在云服务器上,实现数据化采集 便捷、智能、云端,让您随时随地工作!

数据采集

支持多级、多页、分页采集、自定义采集规则(支持正则、XPATH、JSON等)精准匹配任意信息流,可以采集几乎所有网页类型,绝对可以智能识别大部分文章类型的页面内容

内容发布

无缝对接各类cms建站程序,实现免登录数据导入,支持自定义数据发布插件,或直接导入数据库,存储为Excel文件,生成API接口等。

自动化和云平台

软件实现定时定量自动采集发布,无需人工干预!内置云平台,用户可以分享下载采集规则,发布供求信息,社区帮助,交流等。

指示

升级软件

可以直接在后台首页检测更新点击升级,或者将压缩包上传到服务器解压覆盖!

安装软件

将下载的软件上传到您的服务器。如果根目录下有站点,建议放在子目录下。解压后打开浏览器输入你的服务器域名或IP地址(如果存放在子目录中,添加子目录的名称),进入安装界面

点击“接受”进入环境检测页面

必须确保所有参数正确,否则使用过程中会出现错误,点击“下一步”进入数据安装界面

填写数据库和创始人配置,点击“下一步”

最终安装完成,您现在可以使用 优采云采集器! 查看全部

云端 自动 采集(软件特色关于软件优采云采集器(SkyCaiji)数据自动化采集发布软件)

优采云采集器是一款基于云端的自动化数据采集发布软件。系统采用PHP+Mysql开发,可部署在云服务器上。非常强大,几乎可以采集所有类型,还可以自定义采集规则,支持正则化、XPATH、JSON等,还可以定量自动发布采集在一个定期进行,无需人工干预。是大数据和云时代网站Data Automation发布的最好的云爬虫系统采集。

软件功能

关于软件

优采云采集器(SkyCaiji),致力于发布网站数据自动化采集,系统采用PHP+Mysql开发,可部署在云服务器上,实现数据化采集 便捷、智能、云端,让您随时随地工作!

数据采集

支持多级、多页、分页采集、自定义采集规则(支持正则、XPATH、JSON等)精准匹配任意信息流,可以采集几乎所有网页类型,绝对可以智能识别大部分文章类型的页面内容

内容发布

无缝对接各类cms建站程序,实现免登录数据导入,支持自定义数据发布插件,或直接导入数据库,存储为Excel文件,生成API接口等。

自动化和云平台

软件实现定时定量自动采集发布,无需人工干预!内置云平台,用户可以分享下载采集规则,发布供求信息,社区帮助,交流等。

指示

升级软件

可以直接在后台首页检测更新点击升级,或者将压缩包上传到服务器解压覆盖!

安装软件

将下载的软件上传到您的服务器。如果根目录下有站点,建议放在子目录下。解压后打开浏览器输入你的服务器域名或IP地址(如果存放在子目录中,添加子目录的名称),进入安装界面

点击“接受”进入环境检测页面

必须确保所有参数正确,否则使用过程中会出现错误,点击“下一步”进入数据安装界面

填写数据库和创始人配置,点击“下一步”

最终安装完成,您现在可以使用 优采云采集器!

云端 自动 采集(网络爬虫管理工具应用行业领域的五个功能特点及应用)

采集交流 • 优采云 发表了文章 • 0 个评论 • 94 次浏览 • 2021-12-31 00:25

第一章概述

集佳《网络爬虫管理工具》是一款通用的网页数据采集器,由管理工具、爬虫工具和爬虫数据库三部分组成。可以代替人自动采集,组织互联网上的数据信息,快速将网页数据转化为结构化数据,并以EXCEL等多种形式存储。本产品可用于舆情监测、市场分析、产品开发、风险预测等多种业务场景,支持傻瓜式可视化直观操作,分布式爬虫统一调度管理,一键自动云采集、采集优秀数据采集工具,自动去除重复数据,支持多种格式数据导出。

第 2 章特点

极家《网络爬虫管理工具》简单易用,无需技术基础即可快速上手。工作人员可以通过设置爬取规则来启动爬虫。爬虫会按照预设的设置高效高效地执行数据和信息采集,避免人工采集费时费力,数据采集无,效率低的弊端。

极家网络爬虫工具有以下五个特点:

1、操作简单,直观直观,不懂技术也能快速上手

2、适用于全网,看到就捡

3、多种形式,支持本地采集和云端采集,自定义采集和智能采集

4、智能,采集对数据自动去重、自动分词、多格式数据导出

5、 速度快,5分钟从海量数据中挖掘出目标信息

第三章 适用对象

适用对象1:不分行业领域,需要大量数据采集,信息采集适合工作

适用对象2:不分行业领域,适用于需要大范围数据监控和信息监控的工作

第四章 应用场景

网络爬虫管理工具的应用行业不限,场景很多,包括但不限于以下场景。需要采集数据、采集信息、监控数据信息的工作都可以由爬虫来完成。

场景一:企业舆情口碑监测

企业在进行市场声誉评估和监测时会遇到很多困难。无法在线检索信息,追溯时间跨度长,信息格式不规范,统计难度大。企业监控人员每天都需要不停地上网搜索,登录大量网站,而且要追查很长时间,费时费力,效率低下,存在很高的风险。遗漏的可能性。

整理好爬虫工具后,操作简单,设置网站,关键词,爬取规则,5分钟即可获取大量数据,下载到指定位置,导出多种格式的数据供营销人员进行参考分析。

场景二:企业产品或服务市场分析

企业需要定期采集数据来判断自己的产品或服务,在市场上的反应,以及市场上竞品的价格、销量、趋势、口碑等信息。然而,人工采集费时费力。丢失数据的可能性非常高。数据的参考值会降低。

爬虫工具部署好后,很快就可以下载目标数据了。不懂技术也能快速上手,5分钟搞定数据,速度快,数据有很高的参考价值。

场景三:产品开发前的市场需求调研

一款产品在研发之前,需要对目标用户的需求进行充分的调研,涉及行业数据、行业信息、竞品数据、竞品信息、用户需求、用户对竞品的反馈等. 这些数据需要从许多在线渠道中找到。充分的市场调研和数据采集是产品设计的重要基础。

爬虫工具部署好后,可以快速抓取目标数据,可以多种格式下载供参考。

场景四:知识和信息储备

获取某一方面的知识,可以针对一些网站,比如知网、喜马拉雅等,有文字知识和视频知识。这些知识数据量大,下载难度大。手动搜索可能会遗漏。

部署爬虫工具后,爬虫可以快速抓取目标数据并下载,省时省力。几天内完成人为的工作量可能需要十多分钟,没有任何遗漏。

第五章应用价值

5.1 企事业单位舆情监测

通过舆情监测,您可以快速了解事件在市场上的企业声誉或舆情,有针对性地保护企业品牌形象。

5.2改进产品或服务

通过爬虫抓取特定信息,发现产品或服务的不足,促进产品和服务的改进,提升产品或服务的竞争力。

5.3 为企业决策提供依据

通过爬虫,您可以监控市场同类产品或服务的市场价格、价值、性能或质量、份额等数据,了解您在市场中的位置和行业趋势,为企业决策提供依据。 查看全部

云端 自动 采集(网络爬虫管理工具应用行业领域的五个功能特点及应用)

第一章概述

集佳《网络爬虫管理工具》是一款通用的网页数据采集器,由管理工具、爬虫工具和爬虫数据库三部分组成。可以代替人自动采集,组织互联网上的数据信息,快速将网页数据转化为结构化数据,并以EXCEL等多种形式存储。本产品可用于舆情监测、市场分析、产品开发、风险预测等多种业务场景,支持傻瓜式可视化直观操作,分布式爬虫统一调度管理,一键自动云采集、采集优秀数据采集工具,自动去除重复数据,支持多种格式数据导出。

第 2 章特点

极家《网络爬虫管理工具》简单易用,无需技术基础即可快速上手。工作人员可以通过设置爬取规则来启动爬虫。爬虫会按照预设的设置高效高效地执行数据和信息采集,避免人工采集费时费力,数据采集无,效率低的弊端。

极家网络爬虫工具有以下五个特点:

1、操作简单,直观直观,不懂技术也能快速上手

2、适用于全网,看到就捡

3、多种形式,支持本地采集和云端采集,自定义采集和智能采集

4、智能,采集对数据自动去重、自动分词、多格式数据导出

5、 速度快,5分钟从海量数据中挖掘出目标信息

第三章 适用对象

适用对象1:不分行业领域,需要大量数据采集,信息采集适合工作

适用对象2:不分行业领域,适用于需要大范围数据监控和信息监控的工作

第四章 应用场景

网络爬虫管理工具的应用行业不限,场景很多,包括但不限于以下场景。需要采集数据、采集信息、监控数据信息的工作都可以由爬虫来完成。

场景一:企业舆情口碑监测

企业在进行市场声誉评估和监测时会遇到很多困难。无法在线检索信息,追溯时间跨度长,信息格式不规范,统计难度大。企业监控人员每天都需要不停地上网搜索,登录大量网站,而且要追查很长时间,费时费力,效率低下,存在很高的风险。遗漏的可能性。

整理好爬虫工具后,操作简单,设置网站,关键词,爬取规则,5分钟即可获取大量数据,下载到指定位置,导出多种格式的数据供营销人员进行参考分析。

场景二:企业产品或服务市场分析

企业需要定期采集数据来判断自己的产品或服务,在市场上的反应,以及市场上竞品的价格、销量、趋势、口碑等信息。然而,人工采集费时费力。丢失数据的可能性非常高。数据的参考值会降低。

爬虫工具部署好后,很快就可以下载目标数据了。不懂技术也能快速上手,5分钟搞定数据,速度快,数据有很高的参考价值。

场景三:产品开发前的市场需求调研

一款产品在研发之前,需要对目标用户的需求进行充分的调研,涉及行业数据、行业信息、竞品数据、竞品信息、用户需求、用户对竞品的反馈等. 这些数据需要从许多在线渠道中找到。充分的市场调研和数据采集是产品设计的重要基础。

爬虫工具部署好后,可以快速抓取目标数据,可以多种格式下载供参考。

场景四:知识和信息储备

获取某一方面的知识,可以针对一些网站,比如知网、喜马拉雅等,有文字知识和视频知识。这些知识数据量大,下载难度大。手动搜索可能会遗漏。

部署爬虫工具后,爬虫可以快速抓取目标数据并下载,省时省力。几天内完成人为的工作量可能需要十多分钟,没有任何遗漏。

第五章应用价值

5.1 企事业单位舆情监测

通过舆情监测,您可以快速了解事件在市场上的企业声誉或舆情,有针对性地保护企业品牌形象。

5.2改进产品或服务

通过爬虫抓取特定信息,发现产品或服务的不足,促进产品和服务的改进,提升产品或服务的竞争力。

5.3 为企业决策提供依据

通过爬虫,您可以监控市场同类产品或服务的市场价格、价值、性能或质量、份额等数据,了解您在市场中的位置和行业趋势,为企业决策提供依据。

云端 自动 采集( 优采云 采集器软件特色操作简单2分钟快速入门(组图))

采集交流 • 优采云 发表了文章 • 0 个评论 • 133 次浏览 • 2021-12-27 12:10

优采云

采集器软件特色操作简单2分钟快速入门(组图))

优采云

采集器是一款实用的网页数据采集神器,操作简单,任何人都可以使用,适用于任何网站,24*7不间断运行,功能强大,无需懂技术,视频教程,一学就会!软件可自动采集

财务数据、季报、年报、财务报告、每日最新净值等,欢迎有需要的用户使用jz5u。

优采云

功能:

简单来说,使用优采云

可以很方便的从任何网页采集

你需要的数据,生成自定义的常规数据格式。优采云

数据采集系统可以做的包括但不限于以下几方面:

1. 监控竞争对手的最新信息,包括商品价格和库存;

2. 各大新闻门户实时监控,自动更新上传最新新闻;

3. 采集

最新最全的招聘信息;

4. 监控各大社交网站、博客,自动抓取企业产品相关评论;

5. 财务数据,如季报、年报、财报,包括自动采集

每日最新净值;

6. 关注各大房地产相关网站,采集

新房、二手房的最新行情;

7. 从各大汽车网站采集

具体的新车和二手车信息;

8. 从行业网站采集

产品目录和产品信息;

9. 发现和采集

潜在客户信息;

10. 同步各大电商平台的商品信息,做到一个平台发布,其他平台自动更新。

软件特点

操作简单,完全可视化的图形操作,不需要专业的IT人员,任何会用电脑上网的人都可以轻松掌握。

2 分钟快速启动

内置从入门到精通的视频教程,2分钟即可上手,还有文档、论坛、qq群等。

拖放采集

过程

模拟一个人的操作思维模式,可以登录、输入数据、点击链接、按钮等,还可以针对不同的情况采用不同的采集程序。

云集

采集任务自动分发到云端多台服务器同时执行,提高采集效率,短时间内可获取数千条信息。

图形识别

内置可扩展的OCR界面,支持对图片中的文字进行分析,可以提取图片上的文字。

定时自动采集

采集任务自动运行,可按指定周期自动采集,还支持最快一分钟一次的实时采集。

利用

是的,而且该版本没有任何功能限制,您可以立即试用并立即安装。

安装技巧

本软件需要.NET3.5 SP1支持,Win 7内置支持,需要安装XP系统,

安装时软件会自动检测是否安装了.NET 3.5 SP1,如果没有安装,会自动从微软官网安装。

中国的安装速度很慢。建议先安装.NET 3.5 SP1,再安装优采云

采集

器。

安装步骤:

1. 先解压所有文件。

2.请双击setup.exe开始安装。

3.安装完成后,可以在开始菜单或桌面找到优采云

采集

器快捷方式。

4. 要启动优采云

采集

器,您需要先登录,然后才能使用各种功能。

5.如果您已经在优采云

网站注册并激活了您的账号,请使用该账号登录。

如果您还没有注册,请先点击登录界面上的注册链接进行注册并激活您的账户。

6. 第一次使用时,请仔细查看使用说明书(第一次使用时,使用说明书只会出现一次)。

7.在开始自己配置任务之前,建议先打开示例任务熟悉软件,然后按照首页的视频教程进行学习和实践。

8.建议新手先学习教程,或者从规则市场和数据市场中寻找自己需要的数据或采集规则。

更新日志

可以将大批量数据导出到多个文件,可以导出超过Excel文件上限的数据。

支持覆盖安装,无需卸载旧版本,直接安装新版本即可,系统会自动升级安装并保留旧版本数据。

数据导出功能大幅提升,修复大量数据无法导出的问题。

优化采集步骤切换下拉列表功能。

单机采集意外终止或未保存数据关闭后,改进数据自动恢复功能,增加进度条,界面更友好。 查看全部

云端 自动 采集(

优采云

采集器软件特色操作简单2分钟快速入门(组图))

优采云

采集器是一款实用的网页数据采集神器,操作简单,任何人都可以使用,适用于任何网站,24*7不间断运行,功能强大,无需懂技术,视频教程,一学就会!软件可自动采集

财务数据、季报、年报、财务报告、每日最新净值等,欢迎有需要的用户使用jz5u。

优采云

功能:

简单来说,使用优采云

可以很方便的从任何网页采集

你需要的数据,生成自定义的常规数据格式。优采云

数据采集系统可以做的包括但不限于以下几方面:

1. 监控竞争对手的最新信息,包括商品价格和库存;

2. 各大新闻门户实时监控,自动更新上传最新新闻;

3. 采集

最新最全的招聘信息;

4. 监控各大社交网站、博客,自动抓取企业产品相关评论;

5. 财务数据,如季报、年报、财报,包括自动采集

每日最新净值;

6. 关注各大房地产相关网站,采集

新房、二手房的最新行情;

7. 从各大汽车网站采集

具体的新车和二手车信息;

8. 从行业网站采集

产品目录和产品信息;

9. 发现和采集

潜在客户信息;

10. 同步各大电商平台的商品信息,做到一个平台发布,其他平台自动更新。

软件特点

操作简单,完全可视化的图形操作,不需要专业的IT人员,任何会用电脑上网的人都可以轻松掌握。

2 分钟快速启动

内置从入门到精通的视频教程,2分钟即可上手,还有文档、论坛、qq群等。

拖放采集

过程

模拟一个人的操作思维模式,可以登录、输入数据、点击链接、按钮等,还可以针对不同的情况采用不同的采集程序。

云集

采集任务自动分发到云端多台服务器同时执行,提高采集效率,短时间内可获取数千条信息。

图形识别

内置可扩展的OCR界面,支持对图片中的文字进行分析,可以提取图片上的文字。

定时自动采集

采集任务自动运行,可按指定周期自动采集,还支持最快一分钟一次的实时采集。

利用

是的,而且该版本没有任何功能限制,您可以立即试用并立即安装。

安装技巧

本软件需要.NET3.5 SP1支持,Win 7内置支持,需要安装XP系统,

安装时软件会自动检测是否安装了.NET 3.5 SP1,如果没有安装,会自动从微软官网安装。

中国的安装速度很慢。建议先安装.NET 3.5 SP1,再安装优采云

采集

器。

安装步骤:

1. 先解压所有文件。

2.请双击setup.exe开始安装。

3.安装完成后,可以在开始菜单或桌面找到优采云

采集

器快捷方式。

4. 要启动优采云

采集

器,您需要先登录,然后才能使用各种功能。

5.如果您已经在优采云

网站注册并激活了您的账号,请使用该账号登录。

如果您还没有注册,请先点击登录界面上的注册链接进行注册并激活您的账户。

6. 第一次使用时,请仔细查看使用说明书(第一次使用时,使用说明书只会出现一次)。

7.在开始自己配置任务之前,建议先打开示例任务熟悉软件,然后按照首页的视频教程进行学习和实践。

8.建议新手先学习教程,或者从规则市场和数据市场中寻找自己需要的数据或采集规则。

更新日志

可以将大批量数据导出到多个文件,可以导出超过Excel文件上限的数据。

支持覆盖安装,无需卸载旧版本,直接安装新版本即可,系统会自动升级安装并保留旧版本数据。

数据导出功能大幅提升,修复大量数据无法导出的问题。

优化采集步骤切换下拉列表功能。

单机采集意外终止或未保存数据关闭后,改进数据自动恢复功能,增加进度条,界面更友好。

云端 自动 采集(云端自动采集器是个坑,第三方要卖网页代码的)

采集交流 • 优采云 发表了文章 • 0 个评论 • 134 次浏览 • 2021-12-23 23:02

云端自动采集器,获取的是web端的链接,自然收费。曾用过thinkphp的免费版,已经很实用了。跟微信公众号等实时互通。-刚搜索了下(好吧,第三方)要卖网页代码的,还不错,要找大牛。优点是有人帮你写后台,不用你自己写,要设置restfulapi,缺点是太贵(千把块钱,10多万的一整套用codepen搭建一个网站的价格)。

一般都是购买一些代码,做一个二次开发,基本用的也是spring框架。代码可以随便改。跟自己一个人编写完全不同。springide也提供了自动化的完成功能,其他就没啥优点了,买点还是有价值的。ps:吐槽下,好多问题,不能提供解决方案的功能,真是nozuonodie。

云采集器是个坑,

云采集器好用的意义就是提供一个基于浏览器解析用户的网页html代码的服务,一旦你不用代码,就可以完全控制这个网页代码了,不用你自己编辑,使用方便,不占内存,不会被360等浏览器兼容问题影响。 查看全部

云端 自动 采集(云端自动采集器是个坑,第三方要卖网页代码的)

云端自动采集器,获取的是web端的链接,自然收费。曾用过thinkphp的免费版,已经很实用了。跟微信公众号等实时互通。-刚搜索了下(好吧,第三方)要卖网页代码的,还不错,要找大牛。优点是有人帮你写后台,不用你自己写,要设置restfulapi,缺点是太贵(千把块钱,10多万的一整套用codepen搭建一个网站的价格)。

一般都是购买一些代码,做一个二次开发,基本用的也是spring框架。代码可以随便改。跟自己一个人编写完全不同。springide也提供了自动化的完成功能,其他就没啥优点了,买点还是有价值的。ps:吐槽下,好多问题,不能提供解决方案的功能,真是nozuonodie。

云采集器是个坑,

云采集器好用的意义就是提供一个基于浏览器解析用户的网页html代码的服务,一旦你不用代码,就可以完全控制这个网页代码了,不用你自己编辑,使用方便,不占内存,不会被360等浏览器兼容问题影响。

云端 自动 采集(云端自动采集器是最新基于python3.5的web程序)

采集交流 • 优采云 发表了文章 • 0 个评论 • 135 次浏览 • 2021-12-23 03:02

云端自动采集器云端自动采集器是最新基于python3.5的web程序,对公司来说比云采集枪、云采集箱好用太多了,但目前云采集枪、云采集箱都没能整合上web方面的功能,云采集器的整合是必然的。

1)公司管理员使用;

2)团队的培训与发展;

3)大数据、电商的采集处理;

4)实现专业定制的推广联盟;

5)利用人工去做大量分类数据自动处理云采集器提供了三个功能方向,整合web的流量入口、页面源码及其二次开发,以及交互效果。

1、采集采集公司自己创建或统一投放的大数据源、同行、微信同行、qq同行,以及web商品列表和详情页面,并进行pv跟踪。

2、内容审核经采集后的商品,进行内容审核,审核后的数据直接嵌入项目或团队的应用代码里。

3、联盟云采集器可以整合同行们提供的网站或联盟信息、地址、banner、小广告信息或公司自己在用的网站和联盟数据,同时对接个推通用的营销广告系统。

作为一名数据从业者,很多都会遇到一些内网上传的需求。比如内网数据放在哪里最好,内网数据库注册机密设置问题,链接如何挂靠到公网,如何推送,如何组织计算机接入上传,以及如何将业务数据转存至https,加密,一些重要的业务信息,比如大数据分析,工商网站等上传问题。有些需求对于普通的hadoop数据库实现较为简单,但是若使用nosql实现则会变得更加复杂一些。

比如接入接口,一方面要考虑数据质量,另一方面则需要考虑数据搬迁问题。根据这些需求,因为工作的接触,对于云采集就相对比较了解,所以就分享一下自己在开发云采集中遇到的相关问题。实现效果工具环境:win764bit,ubuntu18.0464bit,fedora1264bit。

1、根据数据存储方式的不同可以将其划分为单一关联型数据库和多关联型数据库。比如有些公司会根据数据传输的限制直接根据原有数据库中的xx档案进行上传,有些则根据需要进行传输的信息存在不同数据库中。再有可能数据库已经完全变成一个数据库,比如服务器端存储的csv,但是进入存储路径时根据实际需要进行路径划分。如何进行整体路径划分则是根据需要进行一些简单处理。

推荐路径:备注一:仅用来存放数据,所以没有限制。备注二:csv文件要限制行数。先找到对应行数的csv文件,然后将csv直接放在数据库对应路径下即可。备注三:csv内容的中间记录如果有必要也可以需要自定义下记录路径。备注四:csv里带标题,标题与备注里记录的一致。

2、针对单一关联型数据库也可以定义两个关联表 查看全部

云端 自动 采集(云端自动采集器是最新基于python3.5的web程序)

云端自动采集器云端自动采集器是最新基于python3.5的web程序,对公司来说比云采集枪、云采集箱好用太多了,但目前云采集枪、云采集箱都没能整合上web方面的功能,云采集器的整合是必然的。

1)公司管理员使用;

2)团队的培训与发展;

3)大数据、电商的采集处理;

4)实现专业定制的推广联盟;

5)利用人工去做大量分类数据自动处理云采集器提供了三个功能方向,整合web的流量入口、页面源码及其二次开发,以及交互效果。

1、采集采集公司自己创建或统一投放的大数据源、同行、微信同行、qq同行,以及web商品列表和详情页面,并进行pv跟踪。

2、内容审核经采集后的商品,进行内容审核,审核后的数据直接嵌入项目或团队的应用代码里。

3、联盟云采集器可以整合同行们提供的网站或联盟信息、地址、banner、小广告信息或公司自己在用的网站和联盟数据,同时对接个推通用的营销广告系统。

作为一名数据从业者,很多都会遇到一些内网上传的需求。比如内网数据放在哪里最好,内网数据库注册机密设置问题,链接如何挂靠到公网,如何推送,如何组织计算机接入上传,以及如何将业务数据转存至https,加密,一些重要的业务信息,比如大数据分析,工商网站等上传问题。有些需求对于普通的hadoop数据库实现较为简单,但是若使用nosql实现则会变得更加复杂一些。

比如接入接口,一方面要考虑数据质量,另一方面则需要考虑数据搬迁问题。根据这些需求,因为工作的接触,对于云采集就相对比较了解,所以就分享一下自己在开发云采集中遇到的相关问题。实现效果工具环境:win764bit,ubuntu18.0464bit,fedora1264bit。

1、根据数据存储方式的不同可以将其划分为单一关联型数据库和多关联型数据库。比如有些公司会根据数据传输的限制直接根据原有数据库中的xx档案进行上传,有些则根据需要进行传输的信息存在不同数据库中。再有可能数据库已经完全变成一个数据库,比如服务器端存储的csv,但是进入存储路径时根据实际需要进行路径划分。如何进行整体路径划分则是根据需要进行一些简单处理。

推荐路径:备注一:仅用来存放数据,所以没有限制。备注二:csv文件要限制行数。先找到对应行数的csv文件,然后将csv直接放在数据库对应路径下即可。备注三:csv内容的中间记录如果有必要也可以需要自定义下记录路径。备注四:csv里带标题,标题与备注里记录的一致。

2、针对单一关联型数据库也可以定义两个关联表

云端 自动 采集(云端自动采集,一台电脑,你可以用百度的爬虫storm)

采集交流 • 优采云 发表了文章 • 0 个评论 • 108 次浏览 • 2021-12-19 12:11

云端自动采集,一台电脑,你可以自己采集,手机上也有采集工具,百度搜索几米科技采集一下,中文最好还是用谷歌吧,速度没的说,但是要翻墙,接着是迅雷了,

说的云端采集,什么叫云端采集。

就目前来看,国内的上海纽约和pinterest貌似是目前国内最大的。外国的上面有回答已经提到了,推荐一下下面这个网站,可以说是目前国内做的比较精准和全面的原创ui网站,质量的话比pinterest高出不少。

上海纽约的阿朵这家我觉得是性价比比较高的一家。主要它可以搜索全网优质的作品。

互联网上有个叫优采云采集器器的,虽然才刚刚起步,可是已经算做的比较好的了,爬虫方面可以满足我们自动抓取的需求,

个人最近在爬虫上了解到一家。主要做爬虫,还有搜索引擎。算得上是轻公司,很快就上架了。价格便宜,so,真的便宜了。百度爬虫的话,现在都35元了。意思是直接免费用啦。

暂时没发现,国内大部分都是自己爬,并不具备全面采集能力,人家很多机制都是设计好的,我想无论有多高级,爬虫其实是个工具。

这种效率的,我看到过,可以用百度的爬虫storm,github上有。

国内的任意一家都可以。目前的程序大多都可以抓。都能速度还可以。 查看全部

云端 自动 采集(云端自动采集,一台电脑,你可以用百度的爬虫storm)

云端自动采集,一台电脑,你可以自己采集,手机上也有采集工具,百度搜索几米科技采集一下,中文最好还是用谷歌吧,速度没的说,但是要翻墙,接着是迅雷了,

说的云端采集,什么叫云端采集。

就目前来看,国内的上海纽约和pinterest貌似是目前国内最大的。外国的上面有回答已经提到了,推荐一下下面这个网站,可以说是目前国内做的比较精准和全面的原创ui网站,质量的话比pinterest高出不少。

上海纽约的阿朵这家我觉得是性价比比较高的一家。主要它可以搜索全网优质的作品。

互联网上有个叫优采云采集器器的,虽然才刚刚起步,可是已经算做的比较好的了,爬虫方面可以满足我们自动抓取的需求,

个人最近在爬虫上了解到一家。主要做爬虫,还有搜索引擎。算得上是轻公司,很快就上架了。价格便宜,so,真的便宜了。百度爬虫的话,现在都35元了。意思是直接免费用啦。

暂时没发现,国内大部分都是自己爬,并不具备全面采集能力,人家很多机制都是设计好的,我想无论有多高级,爬虫其实是个工具。

这种效率的,我看到过,可以用百度的爬虫storm,github上有。

国内的任意一家都可以。目前的程序大多都可以抓。都能速度还可以。

云端 自动 采集(云端自动采集呀~网页请求提交数据这块api已经基本实现)

采集交流 • 优采云 发表了文章 • 0 个评论 • 109 次浏览 • 2022-02-10 20:07

云端自动采集呀~网页请求提交数据这块api已经基本实现了;web请求由于没有设计密码等限制,所以目前来看还算不够稳定;而云端在稳定性上可以看出一点点优势了。

sdk开发就是各大服务商自己编写自己的代码,比如百度推荐服务就是把百度后台的数据聚合到了自己的服务里面,

并不是。你的意思是在三个网站都存放相同的数据吗?如果是,那就不是云端,而是你自己制定的数据链。如果只是想静态的提供内容,那是的。除非用一个接口来提供不同的存储服务,这个接口可以看成是云端。

在平台上进行数据的统一收集整理,也有称作云端计算。如果你需要将多个数据源提取成共享的服务,可以使用接口服务。还有一种将大量数据提取成共享,

云服务是一种互联网服务,它包括无数个云计算节点和上游的计算资源池。用户服务和客户服务的交互(connect)是在云计算节点集群上发生的。那么,云服务可以使得网站或者应用在网络上共享数据和资源,或者可以使得操作在网络上完成。随着通信技术的发展,云端计算使得网络可以一直保持稳定性。例如,很多应用程序以协作方式工作:服务器建立和维护集群,在各节点之间共享和交换数据。

这些应用程序中包括线上交易服务器,paas平台服务器,单点登录以及移动应用程序等等。但是,一旦存在在网络上进行通信,就意味着集群可能受到网络故障的威胁,但是从用户体验来看,这远远好于中断服务。使用云存储通常不需要用户将请求转发到特定的节点,从而保证服务的持续性。但是,由于节点通常由集群所有用户共享,因此需要保证各用户在同一时间点上享有同一数据。

如果发生同一用户在不同的节点上出现时间差异,就可能导致系统不稳定甚至宕机。在几年前,i/o中断可能意味着client或客户端的整个流程有问题。但是,由于各节点独立和良好的互联互通,通信中断不仅影响网络更会影响用户。为避免在这种情况下出现的用户体验问题,通信中断一般不需要集群进行解决。这种场景和上文提到的原因相似。

与一般的计算机系统相比,为数据中心(datacenter)设计的架构使得网络的并发连接数大大减少(甚至可以大大减少),而且可以自由地制定io优先顺序。通信中断很容易在核心部件设计时避免。但是,在一些极端状况下,网络中断是无法避免的,例如用户没有在同一时间通过同一节点登录多个账户。 查看全部

云端 自动 采集(云端自动采集呀~网页请求提交数据这块api已经基本实现)

云端自动采集呀~网页请求提交数据这块api已经基本实现了;web请求由于没有设计密码等限制,所以目前来看还算不够稳定;而云端在稳定性上可以看出一点点优势了。

sdk开发就是各大服务商自己编写自己的代码,比如百度推荐服务就是把百度后台的数据聚合到了自己的服务里面,

并不是。你的意思是在三个网站都存放相同的数据吗?如果是,那就不是云端,而是你自己制定的数据链。如果只是想静态的提供内容,那是的。除非用一个接口来提供不同的存储服务,这个接口可以看成是云端。

在平台上进行数据的统一收集整理,也有称作云端计算。如果你需要将多个数据源提取成共享的服务,可以使用接口服务。还有一种将大量数据提取成共享,

云服务是一种互联网服务,它包括无数个云计算节点和上游的计算资源池。用户服务和客户服务的交互(connect)是在云计算节点集群上发生的。那么,云服务可以使得网站或者应用在网络上共享数据和资源,或者可以使得操作在网络上完成。随着通信技术的发展,云端计算使得网络可以一直保持稳定性。例如,很多应用程序以协作方式工作:服务器建立和维护集群,在各节点之间共享和交换数据。

这些应用程序中包括线上交易服务器,paas平台服务器,单点登录以及移动应用程序等等。但是,一旦存在在网络上进行通信,就意味着集群可能受到网络故障的威胁,但是从用户体验来看,这远远好于中断服务。使用云存储通常不需要用户将请求转发到特定的节点,从而保证服务的持续性。但是,由于节点通常由集群所有用户共享,因此需要保证各用户在同一时间点上享有同一数据。

如果发生同一用户在不同的节点上出现时间差异,就可能导致系统不稳定甚至宕机。在几年前,i/o中断可能意味着client或客户端的整个流程有问题。但是,由于各节点独立和良好的互联互通,通信中断不仅影响网络更会影响用户。为避免在这种情况下出现的用户体验问题,通信中断一般不需要集群进行解决。这种场景和上文提到的原因相似。

与一般的计算机系统相比,为数据中心(datacenter)设计的架构使得网络的并发连接数大大减少(甚至可以大大减少),而且可以自由地制定io优先顺序。通信中断很容易在核心部件设计时避免。但是,在一些极端状况下,网络中断是无法避免的,例如用户没有在同一时间通过同一节点登录多个账户。

云端 自动 采集(中国it网站爬虫很乱,很多用的是geckojs.js)

采集交流 • 优采云 发表了文章 • 0 个评论 • 83 次浏览 • 2022-02-09 18:01

云端自动采集。

第一点:office系列软件有专门提供爬虫接口,第二点:到搜狗、百度等知名搜索引擎中随便搜索个目标关键词,输入url之后,就会有一堆网站返回给你。

现在开始尝试这个业务了,暂时还没有推广起来,关注,期待成功。

现在中国it网站爬虫很乱,很多用的是geckojs.现在很多中国it网站开始采用geckojs,

参考urllib3.py和geckojs

我现在正在用自己写一个爬虫:geckojs.js

网站做的那么烂还买服务器和域名?

tor框架tor有个很好的框架urllib3.py

geckojs爬虫库(进展)

有,

我有,我也推荐给你们看下,

上面的你只能爬你自己家的,要怎么和网站对接呢

wordpress不可以吗?

可以使用一些轻量级的爬虫框架,

最近在学dom4j,我已经用dom4j完成了一些爬虫,网页检索等的功能,数据量大小也不大,加上我们可以用https,所以不怕被人家封杀(图省事就用https,安全性最高),

自己爬完全可以,也可以定制一个小程序,用于监控和管理,也可以直接爬服务器, 查看全部

云端 自动 采集(中国it网站爬虫很乱,很多用的是geckojs.js)

云端自动采集。

第一点:office系列软件有专门提供爬虫接口,第二点:到搜狗、百度等知名搜索引擎中随便搜索个目标关键词,输入url之后,就会有一堆网站返回给你。

现在开始尝试这个业务了,暂时还没有推广起来,关注,期待成功。

现在中国it网站爬虫很乱,很多用的是geckojs.现在很多中国it网站开始采用geckojs,

参考urllib3.py和geckojs

我现在正在用自己写一个爬虫:geckojs.js

网站做的那么烂还买服务器和域名?

tor框架tor有个很好的框架urllib3.py

geckojs爬虫库(进展)

有,

我有,我也推荐给你们看下,

上面的你只能爬你自己家的,要怎么和网站对接呢

wordpress不可以吗?

可以使用一些轻量级的爬虫框架,

最近在学dom4j,我已经用dom4j完成了一些爬虫,网页检索等的功能,数据量大小也不大,加上我们可以用https,所以不怕被人家封杀(图省事就用https,安全性最高),

自己爬完全可以,也可以定制一个小程序,用于监控和管理,也可以直接爬服务器,

云端 自动 采集(云端自动采集制作之webassembly.js运行.node.net)

采集交流 • 优采云 发表了文章 • 0 个评论 • 79 次浏览 • 2022-02-08 16:02

云端自动采集制作的这个人工方式的工作站叫做webassembly,本质上和用java写的javaweb是一样的,所以自然也就没有虚拟机那么麻烦了,找webassembly文档就可以读懂了。

webassembly是nodejs的新语言,微软开发了webkit(一个actionscript4代替方案)开发了opengl,不过毕竟两个体系不同,

类比c语言等同javaweb.js的话,他在云端就可以直接使用node.js运行.net的webapp了。在服务器的开发上就变成语言的一种了。比如现在的php,ruby,python,lua都是可以的。如果在.netapp的开发上增加一个语言,就变成c#了。所以应该理解为node.js基本就是按照javaweb语言的生态,和后端混合编程架构来做.net的开发的。

因为webapp开发和web开发其实就差了一个ui层和前端页面。webapp的开发里面看看laravel开发的系列项目就知道了,所以.net在前端生态方面整体和javaweb的生态差别还是很大的。

在webapp上学java都可以有webassembly

webassembly适合基于nodejs架构的app开发,并不需要额外的vm.另外建议参考linkedinwebassembly文档:linkedin|webassembly·github

如果需要,webassembly有学习的价值。因为要基于llvm使用多种处理器、操作系统和编译器,并且定制包。用java开发,gc不好用。但是你可以考虑jvm(java虚拟机)。我现在也在学习webassembly,实际上它现在已经离java这个平台更接近,可以运行于开发、测试、部署多种环境。但是不是说node开发webassembly就比java开发webassembly牛,可能这是一个开发方式和业务需求的问题,这点就得看你自己的判断了。 查看全部

云端 自动 采集(云端自动采集制作之webassembly.js运行.node.net)

云端自动采集制作的这个人工方式的工作站叫做webassembly,本质上和用java写的javaweb是一样的,所以自然也就没有虚拟机那么麻烦了,找webassembly文档就可以读懂了。

webassembly是nodejs的新语言,微软开发了webkit(一个actionscript4代替方案)开发了opengl,不过毕竟两个体系不同,

类比c语言等同javaweb.js的话,他在云端就可以直接使用node.js运行.net的webapp了。在服务器的开发上就变成语言的一种了。比如现在的php,ruby,python,lua都是可以的。如果在.netapp的开发上增加一个语言,就变成c#了。所以应该理解为node.js基本就是按照javaweb语言的生态,和后端混合编程架构来做.net的开发的。

因为webapp开发和web开发其实就差了一个ui层和前端页面。webapp的开发里面看看laravel开发的系列项目就知道了,所以.net在前端生态方面整体和javaweb的生态差别还是很大的。

在webapp上学java都可以有webassembly

webassembly适合基于nodejs架构的app开发,并不需要额外的vm.另外建议参考linkedinwebassembly文档:linkedin|webassembly·github

如果需要,webassembly有学习的价值。因为要基于llvm使用多种处理器、操作系统和编译器,并且定制包。用java开发,gc不好用。但是你可以考虑jvm(java虚拟机)。我现在也在学习webassembly,实际上它现在已经离java这个平台更接近,可以运行于开发、测试、部署多种环境。但是不是说node开发webassembly就比java开发webassembly牛,可能这是一个开发方式和业务需求的问题,这点就得看你自己的判断了。

云端 自动 采集(软件特色关于软件优采云采集器(SkyCaiji)数据采集发布软件)

采集交流 • 优采云 发表了文章 • 0 个评论 • 131 次浏览 • 2022-02-07 14:03

优采云采集器是一款免费的数据采集发布爬虫软件,php+mysql开发,可以部署在云服务器上,可以采集各类网页,没有可对接各种cms建站程序,无需登录实时发布数据,全自动无需人工干预,是大数据和云时代最好的云爬虫软件网站数据自动化< @采集!

软件功能

关于软件

优采云采集器(SkyCaiji),致力于发布网站数据自动化采集,系统采用PHP+Mysql开发,可部署在云服务器上,实现数据化采集 便捷、智能、云端,让您随时随地工作!

数据采集

支持多级、多页、分页采集、自定义采集规则(支持正则、XPATH、JSON等)精准匹配任意信息流,可以采集所有类型的网页,绝对可以智能识别大部分文章类型的页面内容

内容发布

无缝对接各类cms建站程序,实现免登录数据导入,支持自定义数据发布插件,或直接导入数据库,存储为Excel文件,生成API接口等。

自动化和云平台

软件实现定时定量自动采集发布,无需人工干预!内置云平台,用户可以分享下载采集规则,发布供求信息,社区帮助,交流等。

指示

升级软件

可以直接在后台首页检测更新点击升级,或者将压缩包上传到服务器解压覆盖!

安装软件

将下载的软件上传到您的服务器。如果根目录下有站点,建议放在子目录下。解压后打开浏览器输入你的服务器域名或IP地址(如果存放在子目录中,添加子目录的名称),进入安装界面

点击“接受”进入环境检测页面

必须确保所有参数正确,否则使用过程中会出现错误,点击“下一步”进入数据安装界面

填写数据库和创始人配置,点击“下一步”

最终安装完成,您现在可以使用 优采云采集器! 查看全部

云端 自动 采集(软件特色关于软件优采云采集器(SkyCaiji)数据采集发布软件)

优采云采集器是一款免费的数据采集发布爬虫软件,php+mysql开发,可以部署在云服务器上,可以采集各类网页,没有可对接各种cms建站程序,无需登录实时发布数据,全自动无需人工干预,是大数据和云时代最好的云爬虫软件网站数据自动化< @采集!

软件功能

关于软件

优采云采集器(SkyCaiji),致力于发布网站数据自动化采集,系统采用PHP+Mysql开发,可部署在云服务器上,实现数据化采集 便捷、智能、云端,让您随时随地工作!

数据采集

支持多级、多页、分页采集、自定义采集规则(支持正则、XPATH、JSON等)精准匹配任意信息流,可以采集所有类型的网页,绝对可以智能识别大部分文章类型的页面内容

内容发布

无缝对接各类cms建站程序,实现免登录数据导入,支持自定义数据发布插件,或直接导入数据库,存储为Excel文件,生成API接口等。

自动化和云平台

软件实现定时定量自动采集发布,无需人工干预!内置云平台,用户可以分享下载采集规则,发布供求信息,社区帮助,交流等。

指示

升级软件

可以直接在后台首页检测更新点击升级,或者将压缩包上传到服务器解压覆盖!

安装软件

将下载的软件上传到您的服务器。如果根目录下有站点,建议放在子目录下。解压后打开浏览器输入你的服务器域名或IP地址(如果存放在子目录中,添加子目录的名称),进入安装界面

点击“接受”进入环境检测页面

必须确保所有参数正确,否则使用过程中会出现错误,点击“下一步”进入数据安装界面

填写数据库和创始人配置,点击“下一步”

最终安装完成,您现在可以使用 优采云采集器!

云端 自动 采集(云采客企业版采集公众号图文消息的经验分享)

采集交流 • 优采云 发表了文章 • 0 个评论 • 122 次浏览 • 2022-02-04 11:03

云端自动采集,目前uc没有发布可以自动采集微信公众号图文素材的插件,所以你可以用云采客等第三方平台,可以批量采集一些图文素材(上万篇公众号图文),云采客支持第三方sdk接入,

昨天我看公众号的文章是可以采集的,

你需要用到云采客的插件来采集。毕竟直接采集真的太慢了。

我用的微信公众号采集工具是:云采客企业版我分享一下我在使用云采客企业版采集公众号图文消息的经验:1。首先需要用云采客企业版插件,免费申请或者先注册为企业会员用户(系统会有学生免费申请机会)2。登录用户登录后,在云采客企业版公众号管理页面中点击【图文消息采集】进入采集页面3。然后我们就可以准备公众号文章素材,右键保存到云采客素材库中,复制文章到公众号编辑器即可。

刚需,推荐用云采客插件批量采集文章素材,可以试试云采客,中国领先第三方平台,每天10万公众号图文消息云采客同步云端,

朋友圈刷到某人转发了公众号有图文消息的文章,点开链接,不是点开图文消息的文章页,显示的是:免费?那就用云采客小程序看一下有没有什么变化吧:链接对应的图文消息已经采集,还可以修改,编辑和发送消息。 查看全部

云端 自动 采集(云采客企业版采集公众号图文消息的经验分享)

云端自动采集,目前uc没有发布可以自动采集微信公众号图文素材的插件,所以你可以用云采客等第三方平台,可以批量采集一些图文素材(上万篇公众号图文),云采客支持第三方sdk接入,

昨天我看公众号的文章是可以采集的,

你需要用到云采客的插件来采集。毕竟直接采集真的太慢了。

我用的微信公众号采集工具是:云采客企业版我分享一下我在使用云采客企业版采集公众号图文消息的经验:1。首先需要用云采客企业版插件,免费申请或者先注册为企业会员用户(系统会有学生免费申请机会)2。登录用户登录后,在云采客企业版公众号管理页面中点击【图文消息采集】进入采集页面3。然后我们就可以准备公众号文章素材,右键保存到云采客素材库中,复制文章到公众号编辑器即可。

刚需,推荐用云采客插件批量采集文章素材,可以试试云采客,中国领先第三方平台,每天10万公众号图文消息云采客同步云端,

朋友圈刷到某人转发了公众号有图文消息的文章,点开链接,不是点开图文消息的文章页,显示的是:免费?那就用云采客小程序看一下有没有什么变化吧:链接对应的图文消息已经采集,还可以修改,编辑和发送消息。

云端 自动 采集(数据采集渠道很多,可以使用爬虫,不需要自己爬取)

采集交流 • 优采云 发表了文章 • 0 个评论 • 111 次浏览 • 2022-02-03 00:02

1 数据的重要性采集

数据采集是数据挖掘的基础。没有数据,挖掘毫无意义。在很多情况下,我们有多少数据源,有多少数据,数据的质量将决定我们挖掘的结果是什么。

2 四种采集方法

3 如何使用开源数据

4 爬虫方式

(1) 使用请求来抓取内容。

(2)使用xpath解析内容,可以通过元素属性进行索引

(3)使用panda保存数据。最后通过panda写XLS或者mysql数据

(3)scapy

5个常见的爬虫

(1)优采云采集器

它不仅可以做抓取工具,还可以做数据清洗、数据分析、数据挖掘和可视化。数据源适用于大部分网页,通过采集规则可以抓取网页上能看到的内容

(2)优采云

免费采集电商、生活服务等。

云采集配置采集任务,一共5000台服务器,通过云节点采集,自动切换多个IP等

(3)地祖克

没有云采集功能,所有爬虫都是在自己的电脑上进行的

6 如何使用日志采集工具

(1) 最大的作用是通过分析用户访问来提高系统性能。

(2)录制的内容一般包括访问了什么频道、进行了哪些操作、用户IP等。

(3)墓地是什么地方?

Burial 是您需要统计数据来计算代码的地方。友盟google分析talkingdata常用的埋点工具。

7 总结

有许多 采集 数据通道。可以自己通过爬虫,也可以使用开源数据源和线程工具。

可以直接从 Kaggle 下载,不需要自己爬。

另一方面,根据我们的需要,需要采集的数据也是不一样的。例如,在交通运输行业,数据 采集 将与摄像头或速度计相关。对于运维人员来说,日志采集和分析是关键 查看全部

云端 自动 采集(数据采集渠道很多,可以使用爬虫,不需要自己爬取)

1 数据的重要性采集

数据采集是数据挖掘的基础。没有数据,挖掘毫无意义。在很多情况下,我们有多少数据源,有多少数据,数据的质量将决定我们挖掘的结果是什么。

2 四种采集方法

3 如何使用开源数据

4 爬虫方式

(1) 使用请求来抓取内容。

(2)使用xpath解析内容,可以通过元素属性进行索引

(3)使用panda保存数据。最后通过panda写XLS或者mysql数据

(3)scapy

5个常见的爬虫

(1)优采云采集器

它不仅可以做抓取工具,还可以做数据清洗、数据分析、数据挖掘和可视化。数据源适用于大部分网页,通过采集规则可以抓取网页上能看到的内容

(2)优采云

免费采集电商、生活服务等。

云采集配置采集任务,一共5000台服务器,通过云节点采集,自动切换多个IP等

(3)地祖克

没有云采集功能,所有爬虫都是在自己的电脑上进行的

6 如何使用日志采集工具

(1) 最大的作用是通过分析用户访问来提高系统性能。

(2)录制的内容一般包括访问了什么频道、进行了哪些操作、用户IP等。

(3)墓地是什么地方?

Burial 是您需要统计数据来计算代码的地方。友盟google分析talkingdata常用的埋点工具。

7 总结

有许多 采集 数据通道。可以自己通过爬虫,也可以使用开源数据源和线程工具。

可以直接从 Kaggle 下载,不需要自己爬。

另一方面,根据我们的需要,需要采集的数据也是不一样的。例如,在交通运输行业,数据 采集 将与摄像头或速度计相关。对于运维人员来说,日志采集和分析是关键

云端 自动 采集(做线上挂号(电子健康卡)的智能贩卖机)

采集交流 • 优采云 发表了文章 • 0 个评论 • 154 次浏览 • 2022-02-02 08:03

云端自动采集。就是发布任务时把任务的需求和做过的效果图(自己抠来)发给远程服务器,服务器自动抓取数据并自动推送给你。(我觉得也就算个幻想了,即使有云端采集也不可能保证自动去采集什么东西,个人认为云端的最终目的应该是服务大众吧。

微信预约挂号做过一回第三方通过群里的信息和直接后台数据抓取结合预约信息做过一次,同时维护,

您好。做线上挂号(电子健康卡)的智能贩卖机。目前,智能售卖机的打开率较低,是一个痛点。目前,希望解决这个痛点的话,希望有以下几点。

1、可以算法判断,发放个人健康卡的人,是否出现了吸烟的情况。是否出现过食物中毒、小感冒、肺炎、急性肠胃炎、急性阑尾炎、急性眼结膜炎、急性结膜炎、急性炎症性股膜炎、急性上呼吸道炎症等等,智能贩卖机直接有相应的预约工具。

2、把线下实体对接线上线上智能售卖机,通过京东微信公众号、支付宝小程序或者微信小程序实现线上线下全程引流。那么,线上的数据如何处理和匹配?根据我的观察,行业app的用户,普遍重视线下服务,而线下服务数据与线上对接起来比较难。所以,打通线上和线下,不是让线上的流量流入到线下,而是需要整合线上,既让线上的流量流入到线下。比如商户app,可以预约线下办理银行卡。

3、技术打通,结合ai。售卖机,根据客户的实际需求点,自动切换。根据顾客提供的挂号单,来做出个性化服务。避免人工解决问题。这样,能够满足健康贩卖机,尤其是医院门口这个场景对健康的需求。

4、发卡渠道。传统的发卡渠道,手机app或者公众号都可以,加上网络云端平台,大大减少了实体店的人力资源。也解决了实体店的人员问题。手机app最为广泛。目前的售卖机,使用银行app为主,工作时间段是工作时间,顾客会使用手机打开app,所以,会有实体店限制。其次,就是加入云端平台,利用人工智能来解决人力的问题。希望能够帮到您。 查看全部

云端 自动 采集(做线上挂号(电子健康卡)的智能贩卖机)

云端自动采集。就是发布任务时把任务的需求和做过的效果图(自己抠来)发给远程服务器,服务器自动抓取数据并自动推送给你。(我觉得也就算个幻想了,即使有云端采集也不可能保证自动去采集什么东西,个人认为云端的最终目的应该是服务大众吧。

微信预约挂号做过一回第三方通过群里的信息和直接后台数据抓取结合预约信息做过一次,同时维护,

您好。做线上挂号(电子健康卡)的智能贩卖机。目前,智能售卖机的打开率较低,是一个痛点。目前,希望解决这个痛点的话,希望有以下几点。

1、可以算法判断,发放个人健康卡的人,是否出现了吸烟的情况。是否出现过食物中毒、小感冒、肺炎、急性肠胃炎、急性阑尾炎、急性眼结膜炎、急性结膜炎、急性炎症性股膜炎、急性上呼吸道炎症等等,智能贩卖机直接有相应的预约工具。

2、把线下实体对接线上线上智能售卖机,通过京东微信公众号、支付宝小程序或者微信小程序实现线上线下全程引流。那么,线上的数据如何处理和匹配?根据我的观察,行业app的用户,普遍重视线下服务,而线下服务数据与线上对接起来比较难。所以,打通线上和线下,不是让线上的流量流入到线下,而是需要整合线上,既让线上的流量流入到线下。比如商户app,可以预约线下办理银行卡。

3、技术打通,结合ai。售卖机,根据客户的实际需求点,自动切换。根据顾客提供的挂号单,来做出个性化服务。避免人工解决问题。这样,能够满足健康贩卖机,尤其是医院门口这个场景对健康的需求。

4、发卡渠道。传统的发卡渠道,手机app或者公众号都可以,加上网络云端平台,大大减少了实体店的人力资源。也解决了实体店的人员问题。手机app最为广泛。目前的售卖机,使用银行app为主,工作时间段是工作时间,顾客会使用手机打开app,所以,会有实体店限制。其次,就是加入云端平台,利用人工智能来解决人力的问题。希望能够帮到您。

云端 自动 采集(EditorTools——中小网站自动更新利器!(图))

采集交流 • 优采云 发表了文章 • 0 个评论 • 122 次浏览 • 2022-01-29 12:08

EditorTools3是一款无人值守的自动采集器,非常值得所有站长朋友使用。可以帮助用户解决中小网站和企业站采集的自动信息化运营,更智能的采集方案保障您的采集内容优质及时更新@网站! EditorTools3的出现将为您节省大量时间,让站长和管理员从繁琐枯燥的网站更新工作中解放出来!

EditorTools - 中小型网站自动更新工具!

免责声明:本软件适用于需要长期更新的非临时网站使用,不需要您对现有论坛或网站进行任何更改。

特点

1、独特的无人值守

ET的设计以提高软件自动化程度为突破口,以达到无人值守、24小时自动化工作的目的。经过测试,ET可以自动运行很长时间,甚至几年。

2、超高稳定性

为了达到无人值守软件的目的,需要长时间稳定运行。 ET在这方面做了很多优化,保证软件可以稳定连续工作,不会出现采集软件。崩溃本身,甚至导致 网站 崩溃。

3、最低资源使用率

ET独立于网站,不消耗宝贵的服务器WEB处理资源,可以在服务器或站长的工作机上工作。

4、严密的数据和网络安全

ET使用网站自带的数据发布接口或程序代码处理发布信息内容,不直接操作网站数据库,避免了任何可能由ET引起的数据安全问题. 采集信息,ET使用标准HTTP端口,不会造成网络安全漏洞。

5、强大而灵活的功能

ET除了一般采集工具的功能外,还可以使用图片水印、防盗链、分页采集、回复采集、登录采集@等功能>、自定义物品、UTF-8、UBB、模拟发布...,让用户灵活实现各种毛发采集需求。

更新内容

1、修复了一些已知问题。 查看全部

云端 自动 采集(EditorTools——中小网站自动更新利器!(图))

EditorTools3是一款无人值守的自动采集器,非常值得所有站长朋友使用。可以帮助用户解决中小网站和企业站采集的自动信息化运营,更智能的采集方案保障您的采集内容优质及时更新@网站! EditorTools3的出现将为您节省大量时间,让站长和管理员从繁琐枯燥的网站更新工作中解放出来!

EditorTools - 中小型网站自动更新工具!

免责声明:本软件适用于需要长期更新的非临时网站使用,不需要您对现有论坛或网站进行任何更改。

特点

1、独特的无人值守

ET的设计以提高软件自动化程度为突破口,以达到无人值守、24小时自动化工作的目的。经过测试,ET可以自动运行很长时间,甚至几年。

2、超高稳定性

为了达到无人值守软件的目的,需要长时间稳定运行。 ET在这方面做了很多优化,保证软件可以稳定连续工作,不会出现采集软件。崩溃本身,甚至导致 网站 崩溃。

3、最低资源使用率

ET独立于网站,不消耗宝贵的服务器WEB处理资源,可以在服务器或站长的工作机上工作。

4、严密的数据和网络安全

ET使用网站自带的数据发布接口或程序代码处理发布信息内容,不直接操作网站数据库,避免了任何可能由ET引起的数据安全问题. 采集信息,ET使用标准HTTP端口,不会造成网络安全漏洞。

5、强大而灵活的功能

ET除了一般采集工具的功能外,还可以使用图片水印、防盗链、分页采集、回复采集、登录采集@等功能>、自定义物品、UTF-8、UBB、模拟发布...,让用户灵活实现各种毛发采集需求。

更新内容

1、修复了一些已知问题。

云端 自动 采集(常用云端服务器ubuntu16.04+icao/mqtt/variety/)

采集交流 • 优采云 发表了文章 • 0 个评论 • 142 次浏览 • 2022-01-22 14:04

云端自动采集,并发连接数目比较多的时候,是比较容易崩溃的。多条线程同时监控,崩溃时间略长一点。常用云端服务器ubuntu16.04+icao/mqtt/variety。当然你可以用virtualbox搭。

这个是有国外团队开发的教程,

环境操作系统:windows10操作系统版本:2014.4.13014.4.13+1步骤:(配置/折腾/省事)

1、采集web接口,

2、将采集的连接进行静态分析,

3、保存到本地

4、进行互联网抓包抓取

云端自动采集确实挺麻烦,不推荐,开发成本极高,采集效率比较差,不如直接在现成的网站站内进行采集,转发网站站内采集信息。云采集有现成的网站站,可以在里面通过爬虫采集,然后再发布到云采集平台,也不影响平台本身运营。可以去发布平台找抓包代理商帮忙,很多合作方的,我们在里面采集效率比较高,花费用比较少,找一个好的代理商比如:采贝云。

本人做的是面向中小型网站的自动化采集工作,好像这块不太熟悉,既然问到这个问题我就说说我的思路吧,希望对你有帮助,自动化采集的方式很多,有基于爬虫抓取的,有基于url规则的,还有自定义分析shell命令的,你首先需要找到需要自动化采集的网站,先在搜索引擎上查找下这个网站需要自动化采集些什么,需要哪些文章内容,然后选择爬虫采集模式,从搜索结果中收集信息,这个工作目前很多平台都可以实现(我用的是采贝云),还有的是基于url规则的,有的是基于链接规则,这个就不细说了。

接下来就是在采贝云平台上设置定时程序并发量了,希望能够帮到你,手机答题,没有详细教程,但是有一点是可以肯定的,就是开发一个程序并不难,难的是如何抓取网站内容。 查看全部

云端 自动 采集(常用云端服务器ubuntu16.04+icao/mqtt/variety/)

云端自动采集,并发连接数目比较多的时候,是比较容易崩溃的。多条线程同时监控,崩溃时间略长一点。常用云端服务器ubuntu16.04+icao/mqtt/variety。当然你可以用virtualbox搭。

这个是有国外团队开发的教程,

环境操作系统:windows10操作系统版本:2014.4.13014.4.13+1步骤:(配置/折腾/省事)

1、采集web接口,

2、将采集的连接进行静态分析,

3、保存到本地

4、进行互联网抓包抓取

云端自动采集确实挺麻烦,不推荐,开发成本极高,采集效率比较差,不如直接在现成的网站站内进行采集,转发网站站内采集信息。云采集有现成的网站站,可以在里面通过爬虫采集,然后再发布到云采集平台,也不影响平台本身运营。可以去发布平台找抓包代理商帮忙,很多合作方的,我们在里面采集效率比较高,花费用比较少,找一个好的代理商比如:采贝云。

本人做的是面向中小型网站的自动化采集工作,好像这块不太熟悉,既然问到这个问题我就说说我的思路吧,希望对你有帮助,自动化采集的方式很多,有基于爬虫抓取的,有基于url规则的,还有自定义分析shell命令的,你首先需要找到需要自动化采集的网站,先在搜索引擎上查找下这个网站需要自动化采集些什么,需要哪些文章内容,然后选择爬虫采集模式,从搜索结果中收集信息,这个工作目前很多平台都可以实现(我用的是采贝云),还有的是基于url规则的,有的是基于链接规则,这个就不细说了。

接下来就是在采贝云平台上设置定时程序并发量了,希望能够帮到你,手机答题,没有详细教程,但是有一点是可以肯定的,就是开发一个程序并不难,难的是如何抓取网站内容。

云端 自动 采集(一个监控SAAS平台,只需要简单配置,释放数据价值 )

采集交流 • 优采云 发表了文章 • 0 个评论 • 176 次浏览 • 2022-01-21 17:11

)

DataFlux是上海住云自主研发的一套统一的大数据分析平台,通过对任意来源、任意类型、任意规模的实时数据进行监测、分析和处理,释放数据价值。

DataFlux 包括五个功能模块:

- 数据包 采集器

- Dataway 数据网关

- DataFlux Studio 实时数据洞察平台

- DataFlux Admin Console 管理后台

- DataFlux.f(x) 实时数据处理开发平台

为企业提供全场景数据洞察分析能力,具有实时性、灵活性、易扩展性、易部署性。

ntpq命令可以用来处理各个时间之间的同步和转换,非常强大。今天给大家分享一个监控SAAS平台,通过简单的配置即可实现站点和业务监控——使用DataFlux采集NTPQ性能指标并分析展示。

安装 DataKit

PS:以Linux系统为例

第一步:执行安装命令

DataKit 安装命令:

DK_FTDATAWAY=[你的 DataWay 网关地址] bash -c "$(curl https://static.dataflux.cn/datakit/install.sh)"

在安装命令中添加DataWay网关地址,然后将安装命令复制到主机执行。

例如:如果DataWay网关的IP地址为1.2.3.4,端口为9528(9528为默认端口),则网关地址为

DK_FTDATAWAY=http://1.2.3.4:9528/v1/write/metrics bash -c "$(curl https://static.dataflux.cn/datakit/install.sh)"

安装完成后DataKit会默认自动运行,并会在终端提示DataKit状态管理命令

NTPQ 监控指标采集

采集 ntpq 索引报告给 DataFlux

前提

配置

打开DataKit采集源码配置文件夹(默认路径是DataKit安装目录的conf.d文件夹),找到ntpq文件夹,打开里面的ntpq.conf。

设置:

[[inputs.jolokia2_agent]]

name_prefix = "kafka_"

urls = ["http://localhost:8080/jolokia"]

[[inputs.jolokia2_agent.metric]]

name = "controller"

mbean = "kafka.controller:name=*,type=*"

field_prefix = "$1."

[[inputs.jolokia2_agent.metric]]

name = "replica_manager"

mbean = "kafka.server:name=*,type=ReplicaManager"

field_prefix = "$1."

[[inputs.jolokia2_agent.metric]]

name = "purgatory"

mbean = "kafka.server:delayedOperation=*,name=*,type=DelayedOperationPurgatory"

field_prefix = "$1."

field_name = "$2"

[[inputs.jolokia2_agent.metric]]

name = "client"

mbean = "kafka.server:client-id=*,type=*"

tag_keys = ["client-id", "type"]

[[inputs.jolokia2_agent.metric]]

name = "request"

mbean = "kafka.network:name=*,request=*,type=RequestMetrics"

field_prefix = "$1."

tag_keys = ["request"]

[[inputs.jolokia2_agent.metric]]

name = "topics"

mbean = "kafka.server:name=*,type=BrokerTopicMetrics"

field_prefix = "$1."

[[inputs.jolokia2_agent.metric]]

name = "topic"

mbean = "kafka.server:name=*,topic=*,type=BrokerTopicMetrics"

field_prefix = "$1."

tag_keys = ["topic"]

[[inputs.jolokia2_agent.metric]]

name = "partition"

mbean = "kafka.log:name=*,partition=*,topic=*,type=Log"

field_name = "$1"

tag_keys = ["topic", "partition"]

[[inputs.jolokia2_agent.metric]]

name = "partition"

mbean = "kafka.cluster:name=UnderReplicated,partition=*,topic=*,type=Partition"

field_name = "UnderReplicatedPartitions"

tag_keys = ["topic", "partition"]

配置好后重启DataKit生效

采集指标

验证数据报告

完成数据采集操作后,我们需要验证数据采集是否成功并上报给DataWay,以便日后可以正常分析和展示数据。

操作步骤:登录DataFlux-数据管理-指标浏览-验证数据采集是否成功

DataFlux 的数据洞察力

根据获得的指标进行数据洞察设计,如:

NTPQ 性能监控视图

基于自研DataKit数据(采集器),DataFlux现在可以对接200多种数据协议,包括:云数据采集、应用数据采集、日志数据采集,时序数据上报和常用数据库的数据聚合,帮助企业实现最便捷的IT统一监控。

查看全部

云端 自动 采集(一个监控SAAS平台,只需要简单配置,释放数据价值

)

DataFlux是上海住云自主研发的一套统一的大数据分析平台,通过对任意来源、任意类型、任意规模的实时数据进行监测、分析和处理,释放数据价值。

DataFlux 包括五个功能模块:

- 数据包 采集器

- Dataway 数据网关

- DataFlux Studio 实时数据洞察平台

- DataFlux Admin Console 管理后台

- DataFlux.f(x) 实时数据处理开发平台

为企业提供全场景数据洞察分析能力,具有实时性、灵活性、易扩展性、易部署性。

ntpq命令可以用来处理各个时间之间的同步和转换,非常强大。今天给大家分享一个监控SAAS平台,通过简单的配置即可实现站点和业务监控——使用DataFlux采集NTPQ性能指标并分析展示。

安装 DataKit

PS:以Linux系统为例

第一步:执行安装命令

DataKit 安装命令:

DK_FTDATAWAY=[你的 DataWay 网关地址] bash -c "$(curl https://static.dataflux.cn/datakit/install.sh)"

在安装命令中添加DataWay网关地址,然后将安装命令复制到主机执行。

例如:如果DataWay网关的IP地址为1.2.3.4,端口为9528(9528为默认端口),则网关地址为

DK_FTDATAWAY=http://1.2.3.4:9528/v1/write/metrics bash -c "$(curl https://static.dataflux.cn/datakit/install.sh)"

安装完成后DataKit会默认自动运行,并会在终端提示DataKit状态管理命令

NTPQ 监控指标采集

采集 ntpq 索引报告给 DataFlux

前提

配置

打开DataKit采集源码配置文件夹(默认路径是DataKit安装目录的conf.d文件夹),找到ntpq文件夹,打开里面的ntpq.conf。

设置:

[[inputs.jolokia2_agent]]

name_prefix = "kafka_"

urls = ["http://localhost:8080/jolokia"]

[[inputs.jolokia2_agent.metric]]

name = "controller"

mbean = "kafka.controller:name=*,type=*"

field_prefix = "$1."

[[inputs.jolokia2_agent.metric]]

name = "replica_manager"

mbean = "kafka.server:name=*,type=ReplicaManager"

field_prefix = "$1."

[[inputs.jolokia2_agent.metric]]

name = "purgatory"

mbean = "kafka.server:delayedOperation=*,name=*,type=DelayedOperationPurgatory"

field_prefix = "$1."

field_name = "$2"

[[inputs.jolokia2_agent.metric]]

name = "client"

mbean = "kafka.server:client-id=*,type=*"

tag_keys = ["client-id", "type"]

[[inputs.jolokia2_agent.metric]]

name = "request"

mbean = "kafka.network:name=*,request=*,type=RequestMetrics"

field_prefix = "$1."

tag_keys = ["request"]

[[inputs.jolokia2_agent.metric]]

name = "topics"

mbean = "kafka.server:name=*,type=BrokerTopicMetrics"

field_prefix = "$1."

[[inputs.jolokia2_agent.metric]]

name = "topic"

mbean = "kafka.server:name=*,topic=*,type=BrokerTopicMetrics"

field_prefix = "$1."

tag_keys = ["topic"]

[[inputs.jolokia2_agent.metric]]

name = "partition"

mbean = "kafka.log:name=*,partition=*,topic=*,type=Log"

field_name = "$1"

tag_keys = ["topic", "partition"]

[[inputs.jolokia2_agent.metric]]

name = "partition"

mbean = "kafka.cluster:name=UnderReplicated,partition=*,topic=*,type=Partition"

field_name = "UnderReplicatedPartitions"

tag_keys = ["topic", "partition"]

配置好后重启DataKit生效

采集指标

验证数据报告

完成数据采集操作后,我们需要验证数据采集是否成功并上报给DataWay,以便日后可以正常分析和展示数据。

操作步骤:登录DataFlux-数据管理-指标浏览-验证数据采集是否成功

DataFlux 的数据洞察力

根据获得的指标进行数据洞察设计,如:

NTPQ 性能监控视图

基于自研DataKit数据(采集器),DataFlux现在可以对接200多种数据协议,包括:云数据采集、应用数据采集、日志数据采集,时序数据上报和常用数据库的数据聚合,帮助企业实现最便捷的IT统一监控。

云端 自动 采集(云端自动采集:1)云采集平台大力提升采集响应速度)

采集交流 • 优采云 发表了文章 • 0 个评论 • 144 次浏览 • 2022-01-15 11:01

云端自动采集:

1)云采集平台大力提升采集响应速度,已实现7*24小时全自动,采集速度可达到整体服务器每秒30000条。每秒60条的秒采平台已经达到,采集速度是其他采集平台的十倍,包括全自动esp!做网站的朋友都懂,工作中经常遇到要修改网站超过30000条的字段,这种操作太令人头疼了。针对爬虫返回太慢的问题,云采集工作站实现不间断自动化采集,一台机器工作站集群分时全自动采集,支持获取所有页面数据。(。

2)云采集工作站全站使用redis作为高可用的服务器,实现高效可靠的高可用。使用分布式集群以及数据可视化,有效降低集群单点故障的风险。

3)工作站实现多账号登录,增加了便捷操作保障。云采集在内部使用了云证书,确保服务器安全。ps:有兴趣的朋友可以看看这篇文章,深入了解云采集平台。

1.2:实现全自动采集

1)先把采集需求理解清楚。首先我们要定义采集什么类型文章。

2)要求采集内容尽量统一

3)尽量少进行多次不必要的请求

看到题主的一个第一感觉,就是忽略了编程语言的问题...当然,你没错,这确实很可能就是很多很多人最开始对于网络爬虫的固有误解,而这也只是最开始而已。在爬虫编程语言中,scrapy,scrapy-news都是不错的选择,scrapy已经被大多数程序员所熟知。并且,相对而言,scrapy相对于更加方便,理解。

例如,在scrapy中pipeline的知识就比较简单了,但是你当然不能这么说scrapy文章采集呀(逃爬虫开发通常分为两个步骤,数据采集,和处理数据。前者是后者的基础,后者是对数据采集的补充。爬虫在处理数据的方面,往往有下面一些考虑:需要抓取的文章的特征数据总览:知道了抓取的过程,可以针对一定领域进行特征数据分析,针对文章特征分析,可以对目标文章进行二次编辑,具体的方法在数据采集完成以后,数据库部分就能够自动分析了。

然后需要将抓取来的内容二次编辑,也就是在编辑器或者浏览器里面把编辑好的内容发布出去。完整采集:针对某些单篇或者某个领域,往往会遇到大量的文章,而每篇文章都是数十万甚至上百万的体量,一个爬虫往往满负荷是非常吃力的,完整采集就成了一件相对而言比较困难的事情。如果你有下面这样的需求:你可以根据某一领域抓取来的文章内容和抓取难度定义你需要采集的爬虫文章数量,建议不要多于20篇。具体的一个例子,大家可以参考之前的一篇爬虫专栏文章:python爬虫(。

一)什么样的文章好爬?什么样的文章不好爬?你需要了解的知识:如何优雅的使用python完成一个爬虫? 查看全部

云端 自动 采集(云端自动采集:1)云采集平台大力提升采集响应速度)

云端自动采集:

1)云采集平台大力提升采集响应速度,已实现7*24小时全自动,采集速度可达到整体服务器每秒30000条。每秒60条的秒采平台已经达到,采集速度是其他采集平台的十倍,包括全自动esp!做网站的朋友都懂,工作中经常遇到要修改网站超过30000条的字段,这种操作太令人头疼了。针对爬虫返回太慢的问题,云采集工作站实现不间断自动化采集,一台机器工作站集群分时全自动采集,支持获取所有页面数据。(。

2)云采集工作站全站使用redis作为高可用的服务器,实现高效可靠的高可用。使用分布式集群以及数据可视化,有效降低集群单点故障的风险。

3)工作站实现多账号登录,增加了便捷操作保障。云采集在内部使用了云证书,确保服务器安全。ps:有兴趣的朋友可以看看这篇文章,深入了解云采集平台。

1.2:实现全自动采集

1)先把采集需求理解清楚。首先我们要定义采集什么类型文章。

2)要求采集内容尽量统一

3)尽量少进行多次不必要的请求

看到题主的一个第一感觉,就是忽略了编程语言的问题...当然,你没错,这确实很可能就是很多很多人最开始对于网络爬虫的固有误解,而这也只是最开始而已。在爬虫编程语言中,scrapy,scrapy-news都是不错的选择,scrapy已经被大多数程序员所熟知。并且,相对而言,scrapy相对于更加方便,理解。

例如,在scrapy中pipeline的知识就比较简单了,但是你当然不能这么说scrapy文章采集呀(逃爬虫开发通常分为两个步骤,数据采集,和处理数据。前者是后者的基础,后者是对数据采集的补充。爬虫在处理数据的方面,往往有下面一些考虑:需要抓取的文章的特征数据总览:知道了抓取的过程,可以针对一定领域进行特征数据分析,针对文章特征分析,可以对目标文章进行二次编辑,具体的方法在数据采集完成以后,数据库部分就能够自动分析了。

然后需要将抓取来的内容二次编辑,也就是在编辑器或者浏览器里面把编辑好的内容发布出去。完整采集:针对某些单篇或者某个领域,往往会遇到大量的文章,而每篇文章都是数十万甚至上百万的体量,一个爬虫往往满负荷是非常吃力的,完整采集就成了一件相对而言比较困难的事情。如果你有下面这样的需求:你可以根据某一领域抓取来的文章内容和抓取难度定义你需要采集的爬虫文章数量,建议不要多于20篇。具体的一个例子,大家可以参考之前的一篇爬虫专栏文章:python爬虫(。

一)什么样的文章好爬?什么样的文章不好爬?你需要了解的知识:如何优雅的使用python完成一个爬虫?

云端 自动 采集(网易、腾讯、搜狐、金山差不多了?)

采集交流 • 优采云 发表了文章 • 0 个评论 • 132 次浏览 • 2022-01-15 01:01

云端自动采集很容易,对于初始用户而言就是个普通的采集功能,国内也有很多模仿产品了,有个小而美的motan,他们从测试做起,到qq空间采集,基本跟网易、腾讯、搜狐、金山差不多了,从某种意义上来说,如果这个功能刚好开放给初创公司,说不定会比spider做得好,毕竟功能实用,而且需求也刚好被其他公司找到和满足。云端这块我接触的少,不过从事机器学习机器人研究多年,希望对你有所帮助!。

你需要这样去理解下,什么叫机器学习,所谓人工智能需要深度学习。这里面需要大量的数据。现在很多公司在做对比工作,就是将同类产品拿来横向对比,然后找差距,找不到差距的就单独宣传。我认为是一个非常有效果的举措。

网易视频针对性抓取的未必就是网易,只是技术门槛不高,一切从利益最大化考虑呗!跟其他商家合作,就是从网易买资源,从网易买流量,其他公司从网易的资源买流量就是这样做的!只有向其他公司一起买资源,

其实简单点说就是网易针对性的抓取是以网易网为主打产品,类似于垂直领域挖掘,互联网产品的营销平台性质,另外一方面网易针对性的抓取直接可以为广告商创造利益,

他只是提供用户喜欢的内容, 查看全部

云端 自动 采集(网易、腾讯、搜狐、金山差不多了?)

云端自动采集很容易,对于初始用户而言就是个普通的采集功能,国内也有很多模仿产品了,有个小而美的motan,他们从测试做起,到qq空间采集,基本跟网易、腾讯、搜狐、金山差不多了,从某种意义上来说,如果这个功能刚好开放给初创公司,说不定会比spider做得好,毕竟功能实用,而且需求也刚好被其他公司找到和满足。云端这块我接触的少,不过从事机器学习机器人研究多年,希望对你有所帮助!。

你需要这样去理解下,什么叫机器学习,所谓人工智能需要深度学习。这里面需要大量的数据。现在很多公司在做对比工作,就是将同类产品拿来横向对比,然后找差距,找不到差距的就单独宣传。我认为是一个非常有效果的举措。

网易视频针对性抓取的未必就是网易,只是技术门槛不高,一切从利益最大化考虑呗!跟其他商家合作,就是从网易买资源,从网易买流量,其他公司从网易的资源买流量就是这样做的!只有向其他公司一起买资源,

其实简单点说就是网易针对性的抓取是以网易网为主打产品,类似于垂直领域挖掘,互联网产品的营销平台性质,另外一方面网易针对性的抓取直接可以为广告商创造利益,

他只是提供用户喜欢的内容,

云端 自动 采集(云端自动采集,有区别吗?采集不收费。。)

采集交流 • 优采云 发表了文章 • 0 个评论 • 144 次浏览 • 2022-01-12 00:03

云端自动采集,有区别吗?采集不收费。无奈的是好多up找不到自己要的资源,只能收取一些费用(对于大多数人来说而言,有些稍微贵点,但是总比所以资源都免费的好)。因为我们大多数人都是靠百度云赚钱的。

云盘很好,现在开通会员就送了很多。不像迅雷月月送。

云盘?云盘已经不存在了

有的吧,个人网盘一百多个g,里面每天上传一部正在热映的电影电视剧,一会儿就传过来一大堆,过两天再传,一个星期过去再传,剩下一小部分,然后循环往复,因为确实下载慢。现在又新开通了付费会员,每年送了10个g,就一直用云盘下载了。

up主提供种子(有正版有盗版),在云盘里,一般都会分类到几个大网盘,然后下载链接到up主网盘的种子里,

阿普传输网是一家传输自己的资源到各大网盘,

资源自己搬,100块/年。还会员无价,可以每天送200个地址。

年费也就2块钱多一点。已经没有了。

其实没有多少人会自己下吧或者人肉去搬,

两块钱一年,价格很便宜的了,搬起来确实很难过。

什么时候都可以自己下,不要说原始目录,新增加的目录都可以自己修改,用ftp工具自己每天输入链接名下载也很方便啊,资源丢了再删,不会造成资源上传者流量损失,所以不会吃饱了撑的去麻烦别人。 查看全部

云端 自动 采集(云端自动采集,有区别吗?采集不收费。。)

云端自动采集,有区别吗?采集不收费。无奈的是好多up找不到自己要的资源,只能收取一些费用(对于大多数人来说而言,有些稍微贵点,但是总比所以资源都免费的好)。因为我们大多数人都是靠百度云赚钱的。

云盘很好,现在开通会员就送了很多。不像迅雷月月送。

云盘?云盘已经不存在了

有的吧,个人网盘一百多个g,里面每天上传一部正在热映的电影电视剧,一会儿就传过来一大堆,过两天再传,一个星期过去再传,剩下一小部分,然后循环往复,因为确实下载慢。现在又新开通了付费会员,每年送了10个g,就一直用云盘下载了。

up主提供种子(有正版有盗版),在云盘里,一般都会分类到几个大网盘,然后下载链接到up主网盘的种子里,

阿普传输网是一家传输自己的资源到各大网盘,

资源自己搬,100块/年。还会员无价,可以每天送200个地址。

年费也就2块钱多一点。已经没有了。

其实没有多少人会自己下吧或者人肉去搬,

两块钱一年,价格很便宜的了,搬起来确实很难过。

什么时候都可以自己下,不要说原始目录,新增加的目录都可以自己修改,用ftp工具自己每天输入链接名下载也很方便啊,资源丢了再删,不会造成资源上传者流量损失,所以不会吃饱了撑的去麻烦别人。

云端 自动 采集(如何获取哪些网站的数据?可以试试“小云”)

采集交流 • 优采云 发表了文章 • 0 个评论 • 144 次浏览 • 2022-01-11 17:08

云端自动采集的服务,可以一直开着,只要你的数据不丢失,每隔一段时间就会自动定期采集一次。这个真的很不错,比如说我有几千个网站,每个网站都对应一个数据源。我要做推广的时候,我就把采集到的这些网站都开一个账号,每过一段时间就采集一次我要的信息。自己的网站也是如此,每个月自动定期采集5000个网站的信息。

手机:小云

华为云:小云,

天天采集,楼主可以试试,首先华为自己有设备,设备又可以送给客户,包月免费用,可以保证时效性。

推荐一个这个团队做的:crypto-different

目前用的最多的还是天天采集专业版小云

我用他们这个了

天天采集

小云,比如搜索很多,用小云采集到搜索后台,直接复制搜索到的数据过来。

推荐下西瓜助手

别人说的都是天天采集。俺推荐迅捷云采集器。比天天采集速度快,稳定,兼容性好。主要是他还免费。我们公司都用他们的,为什么?速度快,因为你会不断的发现采集到的数据好多,比如新的采集数据,新的采集方式。新的不可采集数据,又下到本地等,同时,相对来说本地的可以小工具操作。

想获取哪些网站的数据?

可以试试“小云”

找个靠谱的、不被封的,不然被采集还不知道。 查看全部

云端 自动 采集(如何获取哪些网站的数据?可以试试“小云”)

云端自动采集的服务,可以一直开着,只要你的数据不丢失,每隔一段时间就会自动定期采集一次。这个真的很不错,比如说我有几千个网站,每个网站都对应一个数据源。我要做推广的时候,我就把采集到的这些网站都开一个账号,每过一段时间就采集一次我要的信息。自己的网站也是如此,每个月自动定期采集5000个网站的信息。

手机:小云

华为云:小云,

天天采集,楼主可以试试,首先华为自己有设备,设备又可以送给客户,包月免费用,可以保证时效性。

推荐一个这个团队做的:crypto-different

目前用的最多的还是天天采集专业版小云

我用他们这个了

天天采集

小云,比如搜索很多,用小云采集到搜索后台,直接复制搜索到的数据过来。

推荐下西瓜助手

别人说的都是天天采集。俺推荐迅捷云采集器。比天天采集速度快,稳定,兼容性好。主要是他还免费。我们公司都用他们的,为什么?速度快,因为你会不断的发现采集到的数据好多,比如新的采集数据,新的采集方式。新的不可采集数据,又下到本地等,同时,相对来说本地的可以小工具操作。

想获取哪些网站的数据?

可以试试“小云”

找个靠谱的、不被封的,不然被采集还不知道。

云端 自动 采集(软件特色关于软件优采云采集器(SkyCaiji)数据自动化采集发布软件)

采集交流 • 优采云 发表了文章 • 0 个评论 • 155 次浏览 • 2022-01-10 08:17

优采云采集器是一款基于云端的自动化数据采集发布软件。系统采用PHP+Mysql开发,可部署在云服务器上。非常强大,几乎可以采集所有类型,还可以自定义采集规则,支持正则化、XPATH、JSON等,还可以定量自动发布采集在一个定期进行,无需人工干预。是大数据和云时代网站Data Automation发布的最好的云爬虫系统采集。

软件功能

关于软件

优采云采集器(SkyCaiji),致力于发布网站数据自动化采集,系统采用PHP+Mysql开发,可部署在云服务器上,实现数据化采集 便捷、智能、云端,让您随时随地工作!

数据采集

支持多级、多页、分页采集、自定义采集规则(支持正则、XPATH、JSON等)精准匹配任意信息流,可以采集几乎所有网页类型,绝对可以智能识别大部分文章类型的页面内容

内容发布

无缝对接各类cms建站程序,实现免登录数据导入,支持自定义数据发布插件,或直接导入数据库,存储为Excel文件,生成API接口等。

自动化和云平台

软件实现定时定量自动采集发布,无需人工干预!内置云平台,用户可以分享下载采集规则,发布供求信息,社区帮助,交流等。

指示

升级软件

可以直接在后台首页检测更新点击升级,或者将压缩包上传到服务器解压覆盖!

安装软件

将下载的软件上传到您的服务器。如果根目录下有站点,建议放在子目录下。解压后打开浏览器输入你的服务器域名或IP地址(如果存放在子目录中,添加子目录的名称),进入安装界面

点击“接受”进入环境检测页面

必须确保所有参数正确,否则使用过程中会出现错误,点击“下一步”进入数据安装界面

填写数据库和创始人配置,点击“下一步”

最终安装完成,您现在可以使用 优采云采集器! 查看全部

云端 自动 采集(软件特色关于软件优采云采集器(SkyCaiji)数据自动化采集发布软件)

优采云采集器是一款基于云端的自动化数据采集发布软件。系统采用PHP+Mysql开发,可部署在云服务器上。非常强大,几乎可以采集所有类型,还可以自定义采集规则,支持正则化、XPATH、JSON等,还可以定量自动发布采集在一个定期进行,无需人工干预。是大数据和云时代网站Data Automation发布的最好的云爬虫系统采集。

软件功能

关于软件

优采云采集器(SkyCaiji),致力于发布网站数据自动化采集,系统采用PHP+Mysql开发,可部署在云服务器上,实现数据化采集 便捷、智能、云端,让您随时随地工作!

数据采集

支持多级、多页、分页采集、自定义采集规则(支持正则、XPATH、JSON等)精准匹配任意信息流,可以采集几乎所有网页类型,绝对可以智能识别大部分文章类型的页面内容

内容发布

无缝对接各类cms建站程序,实现免登录数据导入,支持自定义数据发布插件,或直接导入数据库,存储为Excel文件,生成API接口等。

自动化和云平台

软件实现定时定量自动采集发布,无需人工干预!内置云平台,用户可以分享下载采集规则,发布供求信息,社区帮助,交流等。

指示

升级软件

可以直接在后台首页检测更新点击升级,或者将压缩包上传到服务器解压覆盖!

安装软件

将下载的软件上传到您的服务器。如果根目录下有站点,建议放在子目录下。解压后打开浏览器输入你的服务器域名或IP地址(如果存放在子目录中,添加子目录的名称),进入安装界面

点击“接受”进入环境检测页面

必须确保所有参数正确,否则使用过程中会出现错误,点击“下一步”进入数据安装界面

填写数据库和创始人配置,点击“下一步”

最终安装完成,您现在可以使用 优采云采集器!

云端 自动 采集(网络爬虫管理工具应用行业领域的五个功能特点及应用)

采集交流 • 优采云 发表了文章 • 0 个评论 • 94 次浏览 • 2021-12-31 00:25

第一章概述

集佳《网络爬虫管理工具》是一款通用的网页数据采集器,由管理工具、爬虫工具和爬虫数据库三部分组成。可以代替人自动采集,组织互联网上的数据信息,快速将网页数据转化为结构化数据,并以EXCEL等多种形式存储。本产品可用于舆情监测、市场分析、产品开发、风险预测等多种业务场景,支持傻瓜式可视化直观操作,分布式爬虫统一调度管理,一键自动云采集、采集优秀数据采集工具,自动去除重复数据,支持多种格式数据导出。

第 2 章特点

极家《网络爬虫管理工具》简单易用,无需技术基础即可快速上手。工作人员可以通过设置爬取规则来启动爬虫。爬虫会按照预设的设置高效高效地执行数据和信息采集,避免人工采集费时费力,数据采集无,效率低的弊端。

极家网络爬虫工具有以下五个特点:

1、操作简单,直观直观,不懂技术也能快速上手

2、适用于全网,看到就捡

3、多种形式,支持本地采集和云端采集,自定义采集和智能采集

4、智能,采集对数据自动去重、自动分词、多格式数据导出

5、 速度快,5分钟从海量数据中挖掘出目标信息

第三章 适用对象

适用对象1:不分行业领域,需要大量数据采集,信息采集适合工作

适用对象2:不分行业领域,适用于需要大范围数据监控和信息监控的工作

第四章 应用场景

网络爬虫管理工具的应用行业不限,场景很多,包括但不限于以下场景。需要采集数据、采集信息、监控数据信息的工作都可以由爬虫来完成。

场景一:企业舆情口碑监测

企业在进行市场声誉评估和监测时会遇到很多困难。无法在线检索信息,追溯时间跨度长,信息格式不规范,统计难度大。企业监控人员每天都需要不停地上网搜索,登录大量网站,而且要追查很长时间,费时费力,效率低下,存在很高的风险。遗漏的可能性。

整理好爬虫工具后,操作简单,设置网站,关键词,爬取规则,5分钟即可获取大量数据,下载到指定位置,导出多种格式的数据供营销人员进行参考分析。

场景二:企业产品或服务市场分析

企业需要定期采集数据来判断自己的产品或服务,在市场上的反应,以及市场上竞品的价格、销量、趋势、口碑等信息。然而,人工采集费时费力。丢失数据的可能性非常高。数据的参考值会降低。

爬虫工具部署好后,很快就可以下载目标数据了。不懂技术也能快速上手,5分钟搞定数据,速度快,数据有很高的参考价值。

场景三:产品开发前的市场需求调研

一款产品在研发之前,需要对目标用户的需求进行充分的调研,涉及行业数据、行业信息、竞品数据、竞品信息、用户需求、用户对竞品的反馈等. 这些数据需要从许多在线渠道中找到。充分的市场调研和数据采集是产品设计的重要基础。

爬虫工具部署好后,可以快速抓取目标数据,可以多种格式下载供参考。

场景四:知识和信息储备

获取某一方面的知识,可以针对一些网站,比如知网、喜马拉雅等,有文字知识和视频知识。这些知识数据量大,下载难度大。手动搜索可能会遗漏。

部署爬虫工具后,爬虫可以快速抓取目标数据并下载,省时省力。几天内完成人为的工作量可能需要十多分钟,没有任何遗漏。

第五章应用价值

5.1 企事业单位舆情监测

通过舆情监测,您可以快速了解事件在市场上的企业声誉或舆情,有针对性地保护企业品牌形象。

5.2改进产品或服务

通过爬虫抓取特定信息,发现产品或服务的不足,促进产品和服务的改进,提升产品或服务的竞争力。

5.3 为企业决策提供依据

通过爬虫,您可以监控市场同类产品或服务的市场价格、价值、性能或质量、份额等数据,了解您在市场中的位置和行业趋势,为企业决策提供依据。 查看全部

云端 自动 采集(网络爬虫管理工具应用行业领域的五个功能特点及应用)

第一章概述

集佳《网络爬虫管理工具》是一款通用的网页数据采集器,由管理工具、爬虫工具和爬虫数据库三部分组成。可以代替人自动采集,组织互联网上的数据信息,快速将网页数据转化为结构化数据,并以EXCEL等多种形式存储。本产品可用于舆情监测、市场分析、产品开发、风险预测等多种业务场景,支持傻瓜式可视化直观操作,分布式爬虫统一调度管理,一键自动云采集、采集优秀数据采集工具,自动去除重复数据,支持多种格式数据导出。

第 2 章特点

极家《网络爬虫管理工具》简单易用,无需技术基础即可快速上手。工作人员可以通过设置爬取规则来启动爬虫。爬虫会按照预设的设置高效高效地执行数据和信息采集,避免人工采集费时费力,数据采集无,效率低的弊端。

极家网络爬虫工具有以下五个特点:

1、操作简单,直观直观,不懂技术也能快速上手

2、适用于全网,看到就捡

3、多种形式,支持本地采集和云端采集,自定义采集和智能采集

4、智能,采集对数据自动去重、自动分词、多格式数据导出

5、 速度快,5分钟从海量数据中挖掘出目标信息

第三章 适用对象

适用对象1:不分行业领域,需要大量数据采集,信息采集适合工作

适用对象2:不分行业领域,适用于需要大范围数据监控和信息监控的工作

第四章 应用场景

网络爬虫管理工具的应用行业不限,场景很多,包括但不限于以下场景。需要采集数据、采集信息、监控数据信息的工作都可以由爬虫来完成。

场景一:企业舆情口碑监测

企业在进行市场声誉评估和监测时会遇到很多困难。无法在线检索信息,追溯时间跨度长,信息格式不规范,统计难度大。企业监控人员每天都需要不停地上网搜索,登录大量网站,而且要追查很长时间,费时费力,效率低下,存在很高的风险。遗漏的可能性。

整理好爬虫工具后,操作简单,设置网站,关键词,爬取规则,5分钟即可获取大量数据,下载到指定位置,导出多种格式的数据供营销人员进行参考分析。

场景二:企业产品或服务市场分析

企业需要定期采集数据来判断自己的产品或服务,在市场上的反应,以及市场上竞品的价格、销量、趋势、口碑等信息。然而,人工采集费时费力。丢失数据的可能性非常高。数据的参考值会降低。

爬虫工具部署好后,很快就可以下载目标数据了。不懂技术也能快速上手,5分钟搞定数据,速度快,数据有很高的参考价值。

场景三:产品开发前的市场需求调研

一款产品在研发之前,需要对目标用户的需求进行充分的调研,涉及行业数据、行业信息、竞品数据、竞品信息、用户需求、用户对竞品的反馈等. 这些数据需要从许多在线渠道中找到。充分的市场调研和数据采集是产品设计的重要基础。

爬虫工具部署好后,可以快速抓取目标数据,可以多种格式下载供参考。

场景四:知识和信息储备

获取某一方面的知识,可以针对一些网站,比如知网、喜马拉雅等,有文字知识和视频知识。这些知识数据量大,下载难度大。手动搜索可能会遗漏。

部署爬虫工具后,爬虫可以快速抓取目标数据并下载,省时省力。几天内完成人为的工作量可能需要十多分钟,没有任何遗漏。

第五章应用价值

5.1 企事业单位舆情监测

通过舆情监测,您可以快速了解事件在市场上的企业声誉或舆情,有针对性地保护企业品牌形象。

5.2改进产品或服务

通过爬虫抓取特定信息,发现产品或服务的不足,促进产品和服务的改进,提升产品或服务的竞争力。

5.3 为企业决策提供依据

通过爬虫,您可以监控市场同类产品或服务的市场价格、价值、性能或质量、份额等数据,了解您在市场中的位置和行业趋势,为企业决策提供依据。

云端 自动 采集( 优采云 采集器软件特色操作简单2分钟快速入门(组图))

采集交流 • 优采云 发表了文章 • 0 个评论 • 133 次浏览 • 2021-12-27 12:10

优采云

采集器软件特色操作简单2分钟快速入门(组图))

优采云

采集器是一款实用的网页数据采集神器,操作简单,任何人都可以使用,适用于任何网站,24*7不间断运行,功能强大,无需懂技术,视频教程,一学就会!软件可自动采集

财务数据、季报、年报、财务报告、每日最新净值等,欢迎有需要的用户使用jz5u。

优采云

功能:

简单来说,使用优采云

可以很方便的从任何网页采集

你需要的数据,生成自定义的常规数据格式。优采云

数据采集系统可以做的包括但不限于以下几方面:

1. 监控竞争对手的最新信息,包括商品价格和库存;

2. 各大新闻门户实时监控,自动更新上传最新新闻;

3. 采集

最新最全的招聘信息;

4. 监控各大社交网站、博客,自动抓取企业产品相关评论;

5. 财务数据,如季报、年报、财报,包括自动采集

每日最新净值;

6. 关注各大房地产相关网站,采集

新房、二手房的最新行情;

7. 从各大汽车网站采集

具体的新车和二手车信息;

8. 从行业网站采集

产品目录和产品信息;

9. 发现和采集

潜在客户信息;

10. 同步各大电商平台的商品信息,做到一个平台发布,其他平台自动更新。

软件特点

操作简单,完全可视化的图形操作,不需要专业的IT人员,任何会用电脑上网的人都可以轻松掌握。

2 分钟快速启动

内置从入门到精通的视频教程,2分钟即可上手,还有文档、论坛、qq群等。

拖放采集

过程

模拟一个人的操作思维模式,可以登录、输入数据、点击链接、按钮等,还可以针对不同的情况采用不同的采集程序。

云集

采集任务自动分发到云端多台服务器同时执行,提高采集效率,短时间内可获取数千条信息。

图形识别

内置可扩展的OCR界面,支持对图片中的文字进行分析,可以提取图片上的文字。

定时自动采集

采集任务自动运行,可按指定周期自动采集,还支持最快一分钟一次的实时采集。

利用

是的,而且该版本没有任何功能限制,您可以立即试用并立即安装。

安装技巧

本软件需要.NET3.5 SP1支持,Win 7内置支持,需要安装XP系统,

安装时软件会自动检测是否安装了.NET 3.5 SP1,如果没有安装,会自动从微软官网安装。

中国的安装速度很慢。建议先安装.NET 3.5 SP1,再安装优采云

采集

器。

安装步骤:

1. 先解压所有文件。

2.请双击setup.exe开始安装。

3.安装完成后,可以在开始菜单或桌面找到优采云

采集

器快捷方式。

4. 要启动优采云

采集

器,您需要先登录,然后才能使用各种功能。

5.如果您已经在优采云

网站注册并激活了您的账号,请使用该账号登录。

如果您还没有注册,请先点击登录界面上的注册链接进行注册并激活您的账户。

6. 第一次使用时,请仔细查看使用说明书(第一次使用时,使用说明书只会出现一次)。

7.在开始自己配置任务之前,建议先打开示例任务熟悉软件,然后按照首页的视频教程进行学习和实践。

8.建议新手先学习教程,或者从规则市场和数据市场中寻找自己需要的数据或采集规则。

更新日志

可以将大批量数据导出到多个文件,可以导出超过Excel文件上限的数据。

支持覆盖安装,无需卸载旧版本,直接安装新版本即可,系统会自动升级安装并保留旧版本数据。

数据导出功能大幅提升,修复大量数据无法导出的问题。

优化采集步骤切换下拉列表功能。

单机采集意外终止或未保存数据关闭后,改进数据自动恢复功能,增加进度条,界面更友好。 查看全部

云端 自动 采集(

优采云

采集器软件特色操作简单2分钟快速入门(组图))

优采云

采集器是一款实用的网页数据采集神器,操作简单,任何人都可以使用,适用于任何网站,24*7不间断运行,功能强大,无需懂技术,视频教程,一学就会!软件可自动采集

财务数据、季报、年报、财务报告、每日最新净值等,欢迎有需要的用户使用jz5u。

优采云

功能:

简单来说,使用优采云

可以很方便的从任何网页采集

你需要的数据,生成自定义的常规数据格式。优采云

数据采集系统可以做的包括但不限于以下几方面:

1. 监控竞争对手的最新信息,包括商品价格和库存;

2. 各大新闻门户实时监控,自动更新上传最新新闻;

3. 采集

最新最全的招聘信息;

4. 监控各大社交网站、博客,自动抓取企业产品相关评论;

5. 财务数据,如季报、年报、财报,包括自动采集

每日最新净值;

6. 关注各大房地产相关网站,采集

新房、二手房的最新行情;

7. 从各大汽车网站采集

具体的新车和二手车信息;

8. 从行业网站采集

产品目录和产品信息;

9. 发现和采集

潜在客户信息;

10. 同步各大电商平台的商品信息,做到一个平台发布,其他平台自动更新。

软件特点

操作简单,完全可视化的图形操作,不需要专业的IT人员,任何会用电脑上网的人都可以轻松掌握。

2 分钟快速启动

内置从入门到精通的视频教程,2分钟即可上手,还有文档、论坛、qq群等。

拖放采集

过程

模拟一个人的操作思维模式,可以登录、输入数据、点击链接、按钮等,还可以针对不同的情况采用不同的采集程序。

云集

采集任务自动分发到云端多台服务器同时执行,提高采集效率,短时间内可获取数千条信息。

图形识别

内置可扩展的OCR界面,支持对图片中的文字进行分析,可以提取图片上的文字。

定时自动采集

采集任务自动运行,可按指定周期自动采集,还支持最快一分钟一次的实时采集。

利用

是的,而且该版本没有任何功能限制,您可以立即试用并立即安装。

安装技巧

本软件需要.NET3.5 SP1支持,Win 7内置支持,需要安装XP系统,

安装时软件会自动检测是否安装了.NET 3.5 SP1,如果没有安装,会自动从微软官网安装。

中国的安装速度很慢。建议先安装.NET 3.5 SP1,再安装优采云

采集

器。

安装步骤:

1. 先解压所有文件。

2.请双击setup.exe开始安装。

3.安装完成后,可以在开始菜单或桌面找到优采云

采集

器快捷方式。

4. 要启动优采云

采集

器,您需要先登录,然后才能使用各种功能。

5.如果您已经在优采云

网站注册并激活了您的账号,请使用该账号登录。

如果您还没有注册,请先点击登录界面上的注册链接进行注册并激活您的账户。

6. 第一次使用时,请仔细查看使用说明书(第一次使用时,使用说明书只会出现一次)。

7.在开始自己配置任务之前,建议先打开示例任务熟悉软件,然后按照首页的视频教程进行学习和实践。

8.建议新手先学习教程,或者从规则市场和数据市场中寻找自己需要的数据或采集规则。

更新日志

可以将大批量数据导出到多个文件,可以导出超过Excel文件上限的数据。

支持覆盖安装,无需卸载旧版本,直接安装新版本即可,系统会自动升级安装并保留旧版本数据。

数据导出功能大幅提升,修复大量数据无法导出的问题。

优化采集步骤切换下拉列表功能。

单机采集意外终止或未保存数据关闭后,改进数据自动恢复功能,增加进度条,界面更友好。

云端 自动 采集(云端自动采集器是个坑,第三方要卖网页代码的)

采集交流 • 优采云 发表了文章 • 0 个评论 • 134 次浏览 • 2021-12-23 23:02

云端自动采集器,获取的是web端的链接,自然收费。曾用过thinkphp的免费版,已经很实用了。跟微信公众号等实时互通。-刚搜索了下(好吧,第三方)要卖网页代码的,还不错,要找大牛。优点是有人帮你写后台,不用你自己写,要设置restfulapi,缺点是太贵(千把块钱,10多万的一整套用codepen搭建一个网站的价格)。

一般都是购买一些代码,做一个二次开发,基本用的也是spring框架。代码可以随便改。跟自己一个人编写完全不同。springide也提供了自动化的完成功能,其他就没啥优点了,买点还是有价值的。ps:吐槽下,好多问题,不能提供解决方案的功能,真是nozuonodie。

云采集器是个坑,

云采集器好用的意义就是提供一个基于浏览器解析用户的网页html代码的服务,一旦你不用代码,就可以完全控制这个网页代码了,不用你自己编辑,使用方便,不占内存,不会被360等浏览器兼容问题影响。 查看全部

云端 自动 采集(云端自动采集器是个坑,第三方要卖网页代码的)

云端自动采集器,获取的是web端的链接,自然收费。曾用过thinkphp的免费版,已经很实用了。跟微信公众号等实时互通。-刚搜索了下(好吧,第三方)要卖网页代码的,还不错,要找大牛。优点是有人帮你写后台,不用你自己写,要设置restfulapi,缺点是太贵(千把块钱,10多万的一整套用codepen搭建一个网站的价格)。

一般都是购买一些代码,做一个二次开发,基本用的也是spring框架。代码可以随便改。跟自己一个人编写完全不同。springide也提供了自动化的完成功能,其他就没啥优点了,买点还是有价值的。ps:吐槽下,好多问题,不能提供解决方案的功能,真是nozuonodie。

云采集器是个坑,

云采集器好用的意义就是提供一个基于浏览器解析用户的网页html代码的服务,一旦你不用代码,就可以完全控制这个网页代码了,不用你自己编辑,使用方便,不占内存,不会被360等浏览器兼容问题影响。

云端 自动 采集(云端自动采集器是最新基于python3.5的web程序)

采集交流 • 优采云 发表了文章 • 0 个评论 • 135 次浏览 • 2021-12-23 03:02

云端自动采集器云端自动采集器是最新基于python3.5的web程序,对公司来说比云采集枪、云采集箱好用太多了,但目前云采集枪、云采集箱都没能整合上web方面的功能,云采集器的整合是必然的。

1)公司管理员使用;

2)团队的培训与发展;

3)大数据、电商的采集处理;

4)实现专业定制的推广联盟;

5)利用人工去做大量分类数据自动处理云采集器提供了三个功能方向,整合web的流量入口、页面源码及其二次开发,以及交互效果。

1、采集采集公司自己创建或统一投放的大数据源、同行、微信同行、qq同行,以及web商品列表和详情页面,并进行pv跟踪。

2、内容审核经采集后的商品,进行内容审核,审核后的数据直接嵌入项目或团队的应用代码里。

3、联盟云采集器可以整合同行们提供的网站或联盟信息、地址、banner、小广告信息或公司自己在用的网站和联盟数据,同时对接个推通用的营销广告系统。

作为一名数据从业者,很多都会遇到一些内网上传的需求。比如内网数据放在哪里最好,内网数据库注册机密设置问题,链接如何挂靠到公网,如何推送,如何组织计算机接入上传,以及如何将业务数据转存至https,加密,一些重要的业务信息,比如大数据分析,工商网站等上传问题。有些需求对于普通的hadoop数据库实现较为简单,但是若使用nosql实现则会变得更加复杂一些。

比如接入接口,一方面要考虑数据质量,另一方面则需要考虑数据搬迁问题。根据这些需求,因为工作的接触,对于云采集就相对比较了解,所以就分享一下自己在开发云采集中遇到的相关问题。实现效果工具环境:win764bit,ubuntu18.0464bit,fedora1264bit。