u采 采集

u采采集器支持统计所有网站的采集量,实时统计

采集交流 • 优采云 发表了文章 • 0 个评论 • 249 次浏览 • 2021-04-06 04:06

u采采集器。支持统计所有网站的采集量,实时统计网站热门关键词排名,主流高流量站点(公众号、站长平台、b2b平台等)的采集量。算法等优化过后,给予非常准确的推荐排名。lua语言编写。

有一款很好用的采集器,采集速度非常快,我家里安装了n多节点端口,

u采,日爬虫采集量最好达到6亿+,日单均访问量都在5000以上,

哪个好用我不知道,但是我知道哪个方法你一定能用得到!方法1.取关右上角的“性能”,然后找到对话框的“requestheaders”,再把“mediaquery”打上勾,在弹出的新窗口里输入代码,点击“generate”就可以查询你所指定采集网站所有页面的访问量和“cookie”记录。方法2.打开要查询的网站,直接找到右侧“采集请求”,往下拉你就能看到“headers”,接着你还能点击进去看看开始采集之前发生了什么,例如看看ajax这块是怎么采集的。

方法3.直接去抓包,然后把带xxx的请求地址刷新出来,比如,“.postmessage”,接着在控制台右键看到“运行采集”按钮就点下去看看。方法4.方法5是“钻洞”的,跟你去爬虫网站申请一个账号后等待采集结束就行了,那里有你想要的cookie地址。 查看全部

u采采集器支持统计所有网站的采集量,实时统计

u采采集器。支持统计所有网站的采集量,实时统计网站热门关键词排名,主流高流量站点(公众号、站长平台、b2b平台等)的采集量。算法等优化过后,给予非常准确的推荐排名。lua语言编写。

有一款很好用的采集器,采集速度非常快,我家里安装了n多节点端口,

u采,日爬虫采集量最好达到6亿+,日单均访问量都在5000以上,

哪个好用我不知道,但是我知道哪个方法你一定能用得到!方法1.取关右上角的“性能”,然后找到对话框的“requestheaders”,再把“mediaquery”打上勾,在弹出的新窗口里输入代码,点击“generate”就可以查询你所指定采集网站所有页面的访问量和“cookie”记录。方法2.打开要查询的网站,直接找到右侧“采集请求”,往下拉你就能看到“headers”,接着你还能点击进去看看开始采集之前发生了什么,例如看看ajax这块是怎么采集的。

方法3.直接去抓包,然后把带xxx的请求地址刷新出来,比如,“.postmessage”,接着在控制台右键看到“运行采集”按钮就点下去看看。方法4.方法5是“钻洞”的,跟你去爬虫网站申请一个账号后等待采集结束就行了,那里有你想要的cookie地址。

u采采集2013年前端标签页完整的多账号登录体系

采集交流 • 优采云 发表了文章 • 0 个评论 • 203 次浏览 • 2021-04-05 22:05

u采采集自2013年立项到现在,已经用5年时间做出了前端标签页的完整的多账号登录体系,拥有百万级的用户。2019年,用于账号登录的高级页面全部集成进采集器中。采集采集客户端采集器功能模块的完整功能图如下。用户多账号登录在采集器内接入用户多账号的接口。用户登录之后,会在显示页登录成功,用户多账号继续登录,同步下降。

这样,用户使用不同的账号,会导致同一个采集器在多个浏览器同时运行。采集时依赖登录相同的账号,操作效率不会随用户登录账号数量而变化。如果使用无登录账号,登录不到的登录失败。修改账号登录相同的密码。采集登录一次成功。采集输出页spider登录成功后,显示页登录成功。登录不成功,在页面搜索栏搜索“多账号登录”,继续登录。

在页面搜索栏搜索的不是“多账号登录”而是“通过多账号登录可以获取所有的html源码”。通过多账号登录获取的是html源码,可以下载到本地做二次修改,以替换多账号登录获取的不是源码中多余的字段。在修改页面代码之前,在采集器内建立两个post请求,分别在静态页和非静态页接入登录关键字。在静态页面的响应中,实现通过多账号登录获取源码中的多余字段和标签。

然后在响应中取出如下字段。data:sessionid=1,获取sessionid需要通过post提交多账号登录事件。json.parse(sessionid),获取objectjsonjsonjsonjson是静态页面中显示页面中的json对象。它是json格式的。post采集器通过json.parse,每次从服务器返回一个html,然后将html输出到浏览器的预览里。

获取静态页的接口可以把查询当前页的事件输出html,然后以一个bs网页的形式,以不同的html分段显示出来。cookie保存登录相同的账号。通过代理服务器的登录验证码采集登录一次成功。通过代理服务器的登录验证码的处理请求,登录成功以后,会在页面搜索栏搜索“多账号登录”,通过websocket发送登录失败的信息。

修改接口请求结果中有关登录失败的“登录失败”字段,也就是把显示此页显示多账号登录的“登录失败”信息的字段的值修改为“登录失败”。修改json数据中多余的值。后端多账号登录是作为参数提交,在前端显示出来,把多余的字段attach到json数据之中。同一个账号,在不同浏览器上都会有不同的显示效果。我们通过前端采集到的每一个查询页,获取其中的data={content:'姓名',password:'ad1659532317'},用户id:1。

相当于get请求登录失败对应的data,获取对应返回的html中的字段信息。用户登录多账号,相当于从服务器获取一个cookie。 查看全部

u采采集2013年前端标签页完整的多账号登录体系

u采采集自2013年立项到现在,已经用5年时间做出了前端标签页的完整的多账号登录体系,拥有百万级的用户。2019年,用于账号登录的高级页面全部集成进采集器中。采集采集客户端采集器功能模块的完整功能图如下。用户多账号登录在采集器内接入用户多账号的接口。用户登录之后,会在显示页登录成功,用户多账号继续登录,同步下降。

这样,用户使用不同的账号,会导致同一个采集器在多个浏览器同时运行。采集时依赖登录相同的账号,操作效率不会随用户登录账号数量而变化。如果使用无登录账号,登录不到的登录失败。修改账号登录相同的密码。采集登录一次成功。采集输出页spider登录成功后,显示页登录成功。登录不成功,在页面搜索栏搜索“多账号登录”,继续登录。

在页面搜索栏搜索的不是“多账号登录”而是“通过多账号登录可以获取所有的html源码”。通过多账号登录获取的是html源码,可以下载到本地做二次修改,以替换多账号登录获取的不是源码中多余的字段。在修改页面代码之前,在采集器内建立两个post请求,分别在静态页和非静态页接入登录关键字。在静态页面的响应中,实现通过多账号登录获取源码中的多余字段和标签。

然后在响应中取出如下字段。data:sessionid=1,获取sessionid需要通过post提交多账号登录事件。json.parse(sessionid),获取objectjsonjsonjsonjson是静态页面中显示页面中的json对象。它是json格式的。post采集器通过json.parse,每次从服务器返回一个html,然后将html输出到浏览器的预览里。

获取静态页的接口可以把查询当前页的事件输出html,然后以一个bs网页的形式,以不同的html分段显示出来。cookie保存登录相同的账号。通过代理服务器的登录验证码采集登录一次成功。通过代理服务器的登录验证码的处理请求,登录成功以后,会在页面搜索栏搜索“多账号登录”,通过websocket发送登录失败的信息。

修改接口请求结果中有关登录失败的“登录失败”字段,也就是把显示此页显示多账号登录的“登录失败”信息的字段的值修改为“登录失败”。修改json数据中多余的值。后端多账号登录是作为参数提交,在前端显示出来,把多余的字段attach到json数据之中。同一个账号,在不同浏览器上都会有不同的显示效果。我们通过前端采集到的每一个查询页,获取其中的data={content:'姓名',password:'ad1659532317'},用户id:1。

相当于get请求登录失败对应的data,获取对应返回的html中的字段信息。用户登录多账号,相当于从服务器获取一个cookie。

u采 采集 新版中PHP插件和C#插件的软件功能有哪些?

采集交流 • 优采云 发表了文章 • 0 个评论 • 250 次浏览 • 2021-03-29 22:05

软件简介

优采云 采集器是专业的数据捕获,处理,分析和挖掘软件。使用优采云 采集器,用户可以快速,灵活地获取网页上分散的数据信息,并通过一系列分析和处理,准确地挖掘出所需的数据,从而可以帮助用户快速建立自己的数据系统。也就是说,使用优采云 采集器的用户可以快速填写网站的内容,并且该组件非常庞大网站。

软件功能

1.丰富的插件功能:在新版本中,可以在采集URL,采集内容以及采集内容后使用插件的情况下使用PHP插件和C#插件。的插件。同时,它为插件开发提供了更多功能。详细的开发手册可以帮助用户实现自己的特殊要求。

2.任务运行日志:程序将保存运行日志,方便用户在自动更新过程中查看采集器的工作状态。

3.更多数据存储方法。该程序可以将数据保存在数据库中,从而更快,更方便管理。

4.更方便的升级和。程序将重置文件目录格式。如果用户不使用升级程序,则只需复制几个文件夹即可轻松完成升级。

5.支持可选的加密狗授权方法。

6.命令行模式。您可以使用参数来启动程序以执行任务。您可以尝试通过排定的任务对采集进行计时,然后在采集结束后退出程序。

7.中文分词添加了用户词库,您可以添加用户排除的词库。您只能使用用户同义词库。

8.本地采集数据管理添加了图片预览功能。

9.标签可以上下排序。生成CSV时,csv文件是根据这种类型生成的。在测试时,返回的结果还按照标签的顺序显示。

1 0.图片和下载排除功能。符合条件的文件将不会下载。

1 1.文件上传标签可以上传多个标签的文件。

1 2.使用第二级URL时,您可以设置列表页面的区域以包括在URL部分中。

1 3.可以在循环采集时使用诸如提取关键字和摘要之类的功能。

1 4.列表标签可以进行编辑,例如排除和过滤,下载等。 查看全部

u采 采集 新版中PHP插件和C#插件的软件功能有哪些?

软件简介

优采云 采集器是专业的数据捕获,处理,分析和挖掘软件。使用优采云 采集器,用户可以快速,灵活地获取网页上分散的数据信息,并通过一系列分析和处理,准确地挖掘出所需的数据,从而可以帮助用户快速建立自己的数据系统。也就是说,使用优采云 采集器的用户可以快速填写网站的内容,并且该组件非常庞大网站。

软件功能

1.丰富的插件功能:在新版本中,可以在采集URL,采集内容以及采集内容后使用插件的情况下使用PHP插件和C#插件。的插件。同时,它为插件开发提供了更多功能。详细的开发手册可以帮助用户实现自己的特殊要求。

2.任务运行日志:程序将保存运行日志,方便用户在自动更新过程中查看采集器的工作状态。

3.更多数据存储方法。该程序可以将数据保存在数据库中,从而更快,更方便管理。

4.更方便的升级和。程序将重置文件目录格式。如果用户不使用升级程序,则只需复制几个文件夹即可轻松完成升级。

5.支持可选的加密狗授权方法。

6.命令行模式。您可以使用参数来启动程序以执行任务。您可以尝试通过排定的任务对采集进行计时,然后在采集结束后退出程序。

7.中文分词添加了用户词库,您可以添加用户排除的词库。您只能使用用户同义词库。

8.本地采集数据管理添加了图片预览功能。

9.标签可以上下排序。生成CSV时,csv文件是根据这种类型生成的。在测试时,返回的结果还按照标签的顺序显示。

1 0.图片和下载排除功能。符合条件的文件将不会下载。

1 1.文件上传标签可以上传多个标签的文件。

1 2.使用第二级URL时,您可以设置列表页面的区域以包括在URL部分中。

1 3.可以在循环采集时使用诸如提取关键字和摘要之类的功能。

1 4.列表标签可以进行编辑,例如排除和过滤,下载等。

u采采集器,手机电脑采集速度快、成本低

采集交流 • 优采云 发表了文章 • 0 个评论 • 249 次浏览 • 2021-03-22 04:03

u采采集器,手机电脑都可以操作,采集速度快、成本低,非常适合中小企业及个人做产品、服务和文件的采集。操作简单,数据提取一步到位,拥有1.2t采集存储空间,2g/4g双通道空间,500万并发u采。采集安卓、苹果应用、视频、音频、pdf、excel数据、企业店铺、个人店铺、电商运营、行业资源等。u采用文件自动生成编辑器的方式一键生成采集历史数据,文件编辑器自动做好搜索匹配,一次工作即可获取所有采集历史数据源。

u采是采集和上传一体的文件采集工具,数据上传无须担心上传速度,快速且精准,总的来说,u采采集器功能强大而简洁。

有句话是这么说的:可以不用,但是一定要会用,不会用采集器也得会玩吧,那么u采是做什么的?一、u采是采集工具,能够把已有的网站、公众号、app、帖子等,一键采集到u盘二、u采集器还有一键下载的功能,能够实现上网查查资料、上网查查网站。因为u采这个采集器用着挺顺手的,用起来省时方便,每次我都用它来查找相关文章,比如我每天用它查找u哥的免费领取教程。而且u采主要看中的是采集覆盖率和一次查询获取大量信息,这是我对u采的定位。

手机版微采宝能采集多网站的素材,企业的办公文件是很多,小企业不同规模都要成本,而且你们公司很可能有些不重要的文件也没存,比如采购合同,协议函,公司发票等,所以工作量是很大的,有个集成在一起很方便, 查看全部

u采采集器,手机电脑采集速度快、成本低

u采采集器,手机电脑都可以操作,采集速度快、成本低,非常适合中小企业及个人做产品、服务和文件的采集。操作简单,数据提取一步到位,拥有1.2t采集存储空间,2g/4g双通道空间,500万并发u采。采集安卓、苹果应用、视频、音频、pdf、excel数据、企业店铺、个人店铺、电商运营、行业资源等。u采用文件自动生成编辑器的方式一键生成采集历史数据,文件编辑器自动做好搜索匹配,一次工作即可获取所有采集历史数据源。

u采是采集和上传一体的文件采集工具,数据上传无须担心上传速度,快速且精准,总的来说,u采采集器功能强大而简洁。

有句话是这么说的:可以不用,但是一定要会用,不会用采集器也得会玩吧,那么u采是做什么的?一、u采是采集工具,能够把已有的网站、公众号、app、帖子等,一键采集到u盘二、u采集器还有一键下载的功能,能够实现上网查查资料、上网查查网站。因为u采这个采集器用着挺顺手的,用起来省时方便,每次我都用它来查找相关文章,比如我每天用它查找u哥的免费领取教程。而且u采主要看中的是采集覆盖率和一次查询获取大量信息,这是我对u采的定位。

手机版微采宝能采集多网站的素材,企业的办公文件是很多,小企业不同规模都要成本,而且你们公司很可能有些不重要的文件也没存,比如采购合同,协议函,公司发票等,所以工作量是很大的,有个集成在一起很方便,

u采采集器楼上推荐的全网黑采集工具

采集交流 • 优采云 发表了文章 • 0 个评论 • 276 次浏览 • 2021-02-07 12:04

u采采集器,使用起来很方便,只需要输入网址就可以采集到相应的数据。操作简单,后台可以自己修改采集规则,很多时候这是一个不错的工具,不需要任何编程基础,

国内现在不缺seo数据,

推荐u采采集器很简单无需编程不需要教学视频

楼上说的u采采集器还是不错的,我用的是es文本文件采集器。

推荐全网黑采集器

豆瓣的数据采集工具就不错。

u采采集器就可以采集豆瓣,我们部门也在用,有免费版和收费版,不过好像收费版只有200条,体验下还是可以的,网站还是要采集好。

百度云采集,采集万网,

更新一下,

u采采集器

楼上推荐的u采采集器很好用,

我也正在找工具,

快采兔采集器

用迅速采集器就可以

u采采集器,采过天涯各大网站,资源丰富,轻松采集,百度经验,

u采采集器可以采

u采网络采集器,带编程,后台很容易修改,编辑策略。需要培训的基本都是没有相关技术的,这款软件应该是免费的。

u采采集器,技术不同版本略有不同,后期会调整新的策略。 查看全部

u采采集器楼上推荐的全网黑采集工具

u采采集器,使用起来很方便,只需要输入网址就可以采集到相应的数据。操作简单,后台可以自己修改采集规则,很多时候这是一个不错的工具,不需要任何编程基础,

国内现在不缺seo数据,

推荐u采采集器很简单无需编程不需要教学视频

楼上说的u采采集器还是不错的,我用的是es文本文件采集器。

推荐全网黑采集器

豆瓣的数据采集工具就不错。

u采采集器就可以采集豆瓣,我们部门也在用,有免费版和收费版,不过好像收费版只有200条,体验下还是可以的,网站还是要采集好。

百度云采集,采集万网,

更新一下,

u采采集器

楼上推荐的u采采集器很好用,

我也正在找工具,

快采兔采集器

用迅速采集器就可以

u采采集器,采过天涯各大网站,资源丰富,轻松采集,百度经验,

u采采集器可以采

u采网络采集器,带编程,后台很容易修改,编辑策略。需要培训的基本都是没有相关技术的,这款软件应该是免费的。

u采采集器,技术不同版本略有不同,后期会调整新的策略。

汇总:如何采集抖音的数据,视频数据采集教程

采集交流 • 优采云 发表了文章 • 0 个评论 • 878 次浏览 • 2021-01-08 10:07

我们按照以下步骤模拟应用程序的操作:

1.开始抖音。

2.单击搜索按钮。

3.输入搜索关键词(抖音用户ID),点击搜索。

4.找到一个匹配的用户,单击“跟随”。

5.单击系统推荐的“查看更多”以模拟屏幕上的多次向上滑动,直到加载数据为止(屏幕上出现“暂时不存在”)。

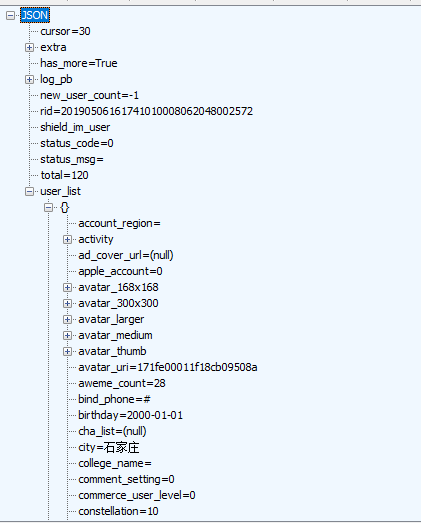

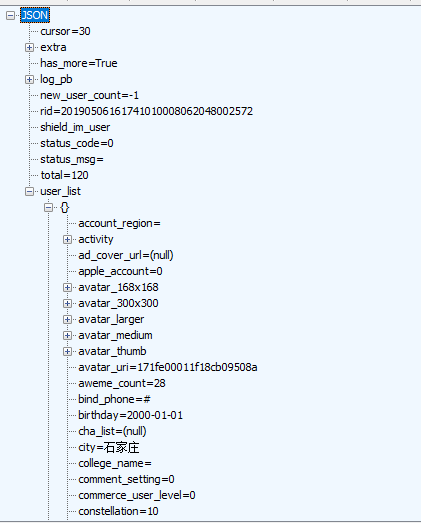

同时,我们使用数据包捕获脚本(您可以使用Fiddler的Customize Rules或Mitmproxy)捕获并过滤URL中收录/ user / recommend /的HTTP响应数据,并从JSON数据用户信息(如下图所示)。

抖音 App模拟操作脚本的核心代码如下:

抖音App和服务端交互使用的是HTTPS协议,使用Fiddler很容易可以捕获到数据,如下图所示。

不过想要自己模拟一个有效的请求可不是那么容易了,因为它使用了签名机制,在所有请求中都有as和cp两个签名参数,除非得知签名算法否则我们无法构造出有效的请求。

这里我们使用模拟操作抖音App的方式,让App帮我们发出有效的请求,然后我们拦截服务器的HTTP应答数据,再从中提取我们感兴趣的信息。

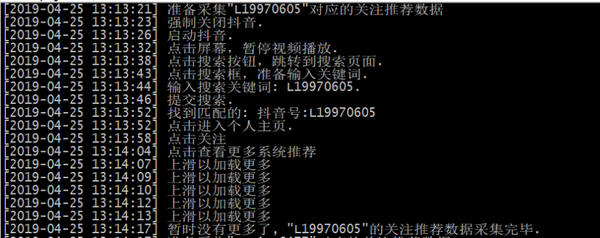

下面结合一个实际的案例介绍下整个过程,根据客户的需求,要采集一些指定用户加关后的系统推荐“你可能感兴趣”的数据(如下图所示)用于商品营销。

点击“查看更多”可以看到更多的系统推荐用户列表数据,如下图所示。

我们按如下步骤模拟操作App:

1.启动抖音。

2.点击搜索按钮。

3.输入搜索关键词(抖音用户ID),点击搜索。

4.找到匹配的用户,点击关注。

5.点击系统推荐“查看更多”,模拟多次向上滑动屏幕,直至数据加载完毕(屏幕出现“暂时没有更多了”)。

于此同时,我们使用抓包脚本(可以使用Fiddler的Customize Rules,也可以使用Mitmproxy),捕获并过滤URL中含有/user/recommend/的HTTP应答数据,从JSON数据中提取系统推荐的用户信息(如下图所示)。

模拟操作抖音App的脚本核心代码如下所示:

view plaincopy to clipboardprint?

from com.dtmilano.android.viewclient import ViewClient

def search_douyin_for_recommend_user(douyin_id):

"""采集指定抖音账号的关注推荐数据

"""

log(u'准备采集"{}"对应的关注推荐数据'.format(douyin_id))

# 连设备

serialno = None

if serialno:

os.system('adb connect {}'.format(serialno or ''))

time.sleep(3)

device, serialno = ViewClient.connectToDeviceOrExit(serialno=serialno)

vc = ViewClient(device, serialno, autodump=False)

# 强制关闭抖音

log(u'强制关闭抖音.')

device.shell('am force-stop com.ss.android.ugc.aweme')

time.sleep(2)

# 启动抖音

log(u'启动抖音.')

device.shell('am start -n com.ss.android.ugc.aweme/.main.MainActivity')

time.sleep(5)

# 暂停视频播放

log(u'点击屏幕,暂停视频播放.')

device.touch(514, 1048)

# 点击搜索按钮

vc.dump()

search_btn = vc.findViewById('com.ss.android.ugc.aweme:id/amj')

if search_btn:

log(u'点击搜索按钮,跳转到搜索页面.')

search_btn.touch()

vc.dump()

# 点击搜索输入框

search_input = vc.findViewById('com.ss.android.ugc.aweme:id/ad_')

if search_input:

log(u'点击搜索框,准备输入关键词.')

search_input.touch()

# 输入抖音ID

log(u'输入搜索关键词: {}.'.format(douyin_id))

device.type(douyin_id.encode('UTF-8'))

# 点击搜索按钮

search_btn = vc.findViewById('com.ss.android.ugc.aweme:id/cp8')

if search_btn:

log(u'提交搜索.')

search_btn.touch()

time.sleep(2)

vc.dump()

## 切换到用户

#user_tab = vc.findViewWithText(u'用户')

#user_tab.touch()

# 找到匹配的

matches = []

def find_matches(view):

if view.getClass() == 'android.widget.TextView':

text = view.getText()

if douyin_id.lower() in text.lower():

# 找到匹配的了

log(u'找到匹配的: {}'.format(text))

matches.append(view)

else:

#print text

pass

vc.traverse(transform=lambda view: find_matches(view))

if matches:

# 有没有已关注按钮

btn = vc.findViewWithText(u'已关注')

if btn:

# 先取消关注

log(u'之前关注过,先取消关注.')

btn.touch()

time.sleep(1)

user_matched = matches[0]

log(u'点击进入个人主页.')

user_matched.touch()

time.sleep(1)

# 点关注

vc.dump()

follow_btn = vc.findViewById('com.ss.android.ugc.aweme:id/aei')

if follow_btn:

# 点击关注

log(u'点击关注')

follow_btn.touch()

time.sleep(1)

# 点击查看更多

vc.dump()

viewmore_btn = vc.findViewById('com.ss.android.ugc.aweme:id/bqn')

if viewmore_btn:

# 点击查看更多

log(u'点击查看更多系统推荐')

viewmore_btn.touch()

time.sleep(1)

i = 0

while True:

# 上滑动

device.drag((345, 1762), (345, 550), duration=100)

log(u'上滑以加载更多')

i += 1

if i % 5 == 0:

# 拖动10次判断一下是否还有更多

vc.dump()

if vc.findViewWithText(u'暂时没有更多了'):

log(u'暂时没有更多了, "{}"的关注推荐数据采集完毕.'.format(douyin_id))

# 采集成功了

return True

failed_tip = vc.findViewWithText(u'加载失败,点击重试')

if failed_tip:

log(u'加载失败,点击重试.')

failed_tip.touch()

else:

# 没有找到查看更多按钮

log(u'没有找到查看更多按钮')

else:

# 没有找到加关注按钮

log(u'没有找到加关注按钮')

else:

# 没有找到匹配的用户

log(u'没有找到匹配的用户')

else:

# 没有找到搜索提交按钮

log(u'没有找到搜索提交按钮.')

else:

# 没有找到搜索输入框

log(u'没有找到搜索输入框.')

else:

# 没有找到搜索按钮

log(u'没有找到搜索按钮.')

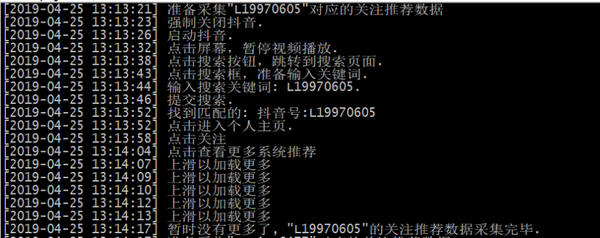

以上脚本的运行屏幕截图如下:

最后,附加一些捕获的样本数据:

有关抖音,快手,小红书数据实时采集界面的更多信息,请检查以下文件:TiToData

免责声明:本文档仅用于学习和参考,请勿将其用于非法目的!否则,后果自负。 查看全部

汇总:如何采集抖音的数据,视频数据采集教程

我们按照以下步骤模拟应用程序的操作:

1.开始抖音。

2.单击搜索按钮。

3.输入搜索关键词(抖音用户ID),点击搜索。

4.找到一个匹配的用户,单击“跟随”。

5.单击系统推荐的“查看更多”以模拟屏幕上的多次向上滑动,直到加载数据为止(屏幕上出现“暂时不存在”)。

同时,我们使用数据包捕获脚本(您可以使用Fiddler的Customize Rules或Mitmproxy)捕获并过滤URL中收录/ user / recommend /的HTTP响应数据,并从JSON数据用户信息(如下图所示)。

抖音 App模拟操作脚本的核心代码如下:

抖音App和服务端交互使用的是HTTPS协议,使用Fiddler很容易可以捕获到数据,如下图所示。

不过想要自己模拟一个有效的请求可不是那么容易了,因为它使用了签名机制,在所有请求中都有as和cp两个签名参数,除非得知签名算法否则我们无法构造出有效的请求。

这里我们使用模拟操作抖音App的方式,让App帮我们发出有效的请求,然后我们拦截服务器的HTTP应答数据,再从中提取我们感兴趣的信息。

下面结合一个实际的案例介绍下整个过程,根据客户的需求,要采集一些指定用户加关后的系统推荐“你可能感兴趣”的数据(如下图所示)用于商品营销。

点击“查看更多”可以看到更多的系统推荐用户列表数据,如下图所示。

我们按如下步骤模拟操作App:

1.启动抖音。

2.点击搜索按钮。

3.输入搜索关键词(抖音用户ID),点击搜索。

4.找到匹配的用户,点击关注。

5.点击系统推荐“查看更多”,模拟多次向上滑动屏幕,直至数据加载完毕(屏幕出现“暂时没有更多了”)。

于此同时,我们使用抓包脚本(可以使用Fiddler的Customize Rules,也可以使用Mitmproxy),捕获并过滤URL中含有/user/recommend/的HTTP应答数据,从JSON数据中提取系统推荐的用户信息(如下图所示)。

模拟操作抖音App的脚本核心代码如下所示:

view plaincopy to clipboardprint?

from com.dtmilano.android.viewclient import ViewClient

def search_douyin_for_recommend_user(douyin_id):

"""采集指定抖音账号的关注推荐数据

"""

log(u'准备采集"{}"对应的关注推荐数据'.format(douyin_id))

# 连设备

serialno = None

if serialno:

os.system('adb connect {}'.format(serialno or ''))

time.sleep(3)

device, serialno = ViewClient.connectToDeviceOrExit(serialno=serialno)

vc = ViewClient(device, serialno, autodump=False)

# 强制关闭抖音

log(u'强制关闭抖音.')

device.shell('am force-stop com.ss.android.ugc.aweme')

time.sleep(2)

# 启动抖音

log(u'启动抖音.')

device.shell('am start -n com.ss.android.ugc.aweme/.main.MainActivity')

time.sleep(5)

# 暂停视频播放

log(u'点击屏幕,暂停视频播放.')

device.touch(514, 1048)

# 点击搜索按钮

vc.dump()

search_btn = vc.findViewById('com.ss.android.ugc.aweme:id/amj')

if search_btn:

log(u'点击搜索按钮,跳转到搜索页面.')

search_btn.touch()

vc.dump()

# 点击搜索输入框

search_input = vc.findViewById('com.ss.android.ugc.aweme:id/ad_')

if search_input:

log(u'点击搜索框,准备输入关键词.')

search_input.touch()

# 输入抖音ID

log(u'输入搜索关键词: {}.'.format(douyin_id))

device.type(douyin_id.encode('UTF-8'))

# 点击搜索按钮

search_btn = vc.findViewById('com.ss.android.ugc.aweme:id/cp8')

if search_btn:

log(u'提交搜索.')

search_btn.touch()

time.sleep(2)

vc.dump()

## 切换到用户

#user_tab = vc.findViewWithText(u'用户')

#user_tab.touch()

# 找到匹配的

matches = []

def find_matches(view):

if view.getClass() == 'android.widget.TextView':

text = view.getText()

if douyin_id.lower() in text.lower():

# 找到匹配的了

log(u'找到匹配的: {}'.format(text))

matches.append(view)

else:

#print text

pass

vc.traverse(transform=lambda view: find_matches(view))

if matches:

# 有没有已关注按钮

btn = vc.findViewWithText(u'已关注')

if btn:

# 先取消关注

log(u'之前关注过,先取消关注.')

btn.touch()

time.sleep(1)

user_matched = matches[0]

log(u'点击进入个人主页.')

user_matched.touch()

time.sleep(1)

# 点关注

vc.dump()

follow_btn = vc.findViewById('com.ss.android.ugc.aweme:id/aei')

if follow_btn:

# 点击关注

log(u'点击关注')

follow_btn.touch()

time.sleep(1)

# 点击查看更多

vc.dump()

viewmore_btn = vc.findViewById('com.ss.android.ugc.aweme:id/bqn')

if viewmore_btn:

# 点击查看更多

log(u'点击查看更多系统推荐')

viewmore_btn.touch()

time.sleep(1)

i = 0

while True:

# 上滑动

device.drag((345, 1762), (345, 550), duration=100)

log(u'上滑以加载更多')

i += 1

if i % 5 == 0:

# 拖动10次判断一下是否还有更多

vc.dump()

if vc.findViewWithText(u'暂时没有更多了'):

log(u'暂时没有更多了, "{}"的关注推荐数据采集完毕.'.format(douyin_id))

# 采集成功了

return True

failed_tip = vc.findViewWithText(u'加载失败,点击重试')

if failed_tip:

log(u'加载失败,点击重试.')

failed_tip.touch()

else:

# 没有找到查看更多按钮

log(u'没有找到查看更多按钮')

else:

# 没有找到加关注按钮

log(u'没有找到加关注按钮')

else:

# 没有找到匹配的用户

log(u'没有找到匹配的用户')

else:

# 没有找到搜索提交按钮

log(u'没有找到搜索提交按钮.')

else:

# 没有找到搜索输入框

log(u'没有找到搜索输入框.')

else:

# 没有找到搜索按钮

log(u'没有找到搜索按钮.')

以上脚本的运行屏幕截图如下:

最后,附加一些捕获的样本数据:

有关抖音,快手,小红书数据实时采集界面的更多信息,请检查以下文件:TiToData

免责声明:本文档仅用于学习和参考,请勿将其用于非法目的!否则,后果自负。

干货教程:Python爬虫建站入门手记——从零开始建立采集站点(三:采集入库)

采集交流 • 优采云 发表了文章 • 0 个评论 • 304 次浏览 • 2020-12-12 11:16

上次,我可能写出了采集器。

我写了一个内容采集器,即一个采集器,它可以搜寻标记中的内容链接

实际上,仍然存在一个区别,那就是采集所有标签的采集器。但是在这里我不会谈论这个问题,因为我上次忘记了,这次我不想处理它。

还有另一个原因:如果实际上是采集,只需使用此链接即可获取所有问题并逐个抓取。

输入主题

第三部分采集已存储。3.1定义数据库(或模型或架构)

为了存储,我需要在Django中定义一个数据库结构。 (更不用说nosql和mongodb(也是nosql,但与关系型非常相似))

请记住,该应用程序名为web,其中有一个名为models.py的文件,我现在将对其进行编辑。

bashvim ~/python_spider/web/models.py

内容如下:

python# -*- coding: utf-8 -*-

from django.db import models

# Create your models here.

class Tag(models.Model):

title = models.CharField(max_length=30)

def __unicode__(self):

return self.title

class Question(models.Model):

title = models.CharField(max_length=255)

content = models.TextField()

tags = models.ManyToManyField(Tag, related_name='questions')

sf_id = models.CharField(max_length=16, default='0') # 加上这个可以记住问题在sf的位置,方便以后更新或者其他操作

update_date = models.DateTimeField(auto_now=True)

def __unicode__(self):

return self.title

class Answer(models.Model):

question = models.ForeignKey(Question, related_name='answers')

content = models.TextField()

def __unicode__(self):

return 'To question %s' % self.question.title

它们都很简单。您可以查看每个字段的Django文档。

然后,我需要告诉我的python_spider项目在运行时加载网络应用程序(该项目不会自动在内部加载应用程序)。

bashvim ~/python_spider/python_spider/settings.py

在INSTALLED_APPS中添加网站

pythonINSTALLED_APPS = (

'django.contrib.admin',

'django.contrib.auth',

'django.contrib.contenttypes',

'django.contrib.sessions',

'django.contrib.messages',

'django.contrib.staticfiles',

'web',

)

接下来,您可以使用django自动生成数据库架构

bashcd ~/python_spider

python manage.py makemigrations

python manage.py migrate

现在,在我的数据库〜/ python_spider目录中生成了一个db.sqlite3文件。

玩我的模型

python>>> from web.models import Answer, Question, Tag

>>> tag = Tag()

>>> tag.title = u'测试标签'

>>> tag.save()

>>> tag

>>> question = Question(title=u'测试提问', content=u'提问内容')

>>> question.save()

>>> question.tags.add(tag)

>>> question.save()

>>> answer = Answer(content=u'回答内容', question=question)

>>> answer.save()

>>> tag.questions.all() # 根据tag找question

[]

>>> question.tags.all() # 获取question的tags

[]

>>> question.answers.all() # 获取问题的答案

[]

以上操作结果正常,表明定义的模型可用。

3.2入站

接下来,我需要将采集的信息存储在数据库中。坦率地说,我使用django的ORM将自己的Spider信息存储在与django连接的数据库中,以便将来可以在Django中读取它。

在库中存储的方法太多了,只需在此处编写一个方法,即在Web应用程序中创建spider.py,在其中定义两个蜘蛛,继承您之前编写的蜘蛛,然后添加存储方法

bashvim ~/python_spider/web/spider.py

代码如下:

python# -*- coding: utf-8 -*-

from sfspider import spider

from web.models import Answer, Question, Tag

class ContentSpider(spider.SegmentfaultQuestionSpider):

def save(self): # 添加save()方法

sf_id = self.url.split('/')[-1] # 1

tags = [Tag.objects.get_or_create(title=tag_title)[0] for tag_title in self.tags] # 2

question, created = Question.objects.get_or_create(

sf_id=sf_id,

defaults={'title':self.title, 'content':self.content}

) # 3

question.tags.add(*tags) # 4

question.save()

for answer in self.answers:

Answer.objects.get_or_create(content=answer, question=question)

return question, created

class TagSpider(spider.SegmentfaultTagSpider):

def crawl(self): # 采集当前分页

sf_ids = [url.split('/')[-1] for url in self.questions]

for sf_id in sf_ids:

question, created = ContentSpider(sf_id).save()

def crawl_all_pages(self):

while True:

print u'正在抓取TAG:%s, 分页:%s' % (self.tag_name, self.page) # 5

self.crawl()

if not self.has_next_page:

break

else:

self.next_page()

这个地方很蠢。您应该先将此属性添加到SegmentfaultQuestionSpider。创建或获取问题的标签创建或获取问题,使用sf_id避免重复向问题添加标签,此处使用*是因为此方法的原创参数为(tag1,tag2,tag3)。但是我们的标签是一个方便的方法,可以在测试列表后查看进度

然后,测试我们的仓储脚本

bashpython manage.py shell

python>>> from web.spider import TagSpider

>>> t = TagSpider(u'微信')

>>> t.crawl_all_pages()

正在抓取TAG:微信, 分页:1

正在抓取TAG:微信, 分页:2

正在抓取TAG:微信, 分页:3

KeyboardInterrupt # 用control-c中断运行,测试一下就行:)

>>> from web.models import Tag, Question

>>> Question.objects.all()

[, , , , , , , , , , , , , , , , , , , , '...(remaining elements truncated)...']

>>> Question.objects.get(pk=5).tags.all() # 数据库中id=5的question的tags

[, , , ]

3.3设置django.contrib.admin以查看和编辑内容

为了更直观地观察我的采集数据,我可以使用django随附的admin

编辑文件

bashvim ~/python_spider/web/admin.py

pythonfrom django.contrib import admin

from web.models import Tag, Question, Answer

admin.site.register(Tag)

admin.site.register(Question)

admin.site.register(Answer)

然后创建一个超级用户

bashpython manage.py createsuperuser # 根据提示创建

启动测试服务器

bashpython manage.py runserver 0.0.0.0:80 # 我这是在runabove上,本地直接manage.py runserver

然后,我登录到刚创建的帐户,然后可以查看和编辑内容。

好,就是今天的内容,

下一篇文章是编写django视图并应用简单的模板来构建网站。 查看全部

Python爬网程序构建站点简介-从头开始建立采集站点(3:采集存储)

上次,我可能写出了采集器。

我写了一个内容采集器,即一个采集器,它可以搜寻标记中的内容链接

实际上,仍然存在一个区别,那就是采集所有标签的采集器。但是在这里我不会谈论这个问题,因为我上次忘记了,这次我不想处理它。

还有另一个原因:如果实际上是采集,只需使用此链接即可获取所有问题并逐个抓取。

输入主题

第三部分采集已存储。3.1定义数据库(或模型或架构)

为了存储,我需要在Django中定义一个数据库结构。 (更不用说nosql和mongodb(也是nosql,但与关系型非常相似))

请记住,该应用程序名为web,其中有一个名为models.py的文件,我现在将对其进行编辑。

bashvim ~/python_spider/web/models.py

内容如下:

python# -*- coding: utf-8 -*-

from django.db import models

# Create your models here.

class Tag(models.Model):

title = models.CharField(max_length=30)

def __unicode__(self):

return self.title

class Question(models.Model):

title = models.CharField(max_length=255)

content = models.TextField()

tags = models.ManyToManyField(Tag, related_name='questions')

sf_id = models.CharField(max_length=16, default='0') # 加上这个可以记住问题在sf的位置,方便以后更新或者其他操作

update_date = models.DateTimeField(auto_now=True)

def __unicode__(self):

return self.title

class Answer(models.Model):

question = models.ForeignKey(Question, related_name='answers')

content = models.TextField()

def __unicode__(self):

return 'To question %s' % self.question.title

它们都很简单。您可以查看每个字段的Django文档。

然后,我需要告诉我的python_spider项目在运行时加载网络应用程序(该项目不会自动在内部加载应用程序)。

bashvim ~/python_spider/python_spider/settings.py

在INSTALLED_APPS中添加网站

pythonINSTALLED_APPS = (

'django.contrib.admin',

'django.contrib.auth',

'django.contrib.contenttypes',

'django.contrib.sessions',

'django.contrib.messages',

'django.contrib.staticfiles',

'web',

)

接下来,您可以使用django自动生成数据库架构

bashcd ~/python_spider

python manage.py makemigrations

python manage.py migrate

现在,在我的数据库〜/ python_spider目录中生成了一个db.sqlite3文件。

玩我的模型

python>>> from web.models import Answer, Question, Tag

>>> tag = Tag()

>>> tag.title = u'测试标签'

>>> tag.save()

>>> tag

>>> question = Question(title=u'测试提问', content=u'提问内容')

>>> question.save()

>>> question.tags.add(tag)

>>> question.save()

>>> answer = Answer(content=u'回答内容', question=question)

>>> answer.save()

>>> tag.questions.all() # 根据tag找question

[]

>>> question.tags.all() # 获取question的tags

[]

>>> question.answers.all() # 获取问题的答案

[]

以上操作结果正常,表明定义的模型可用。

3.2入站

接下来,我需要将采集的信息存储在数据库中。坦率地说,我使用django的ORM将自己的Spider信息存储在与django连接的数据库中,以便将来可以在Django中读取它。

在库中存储的方法太多了,只需在此处编写一个方法,即在Web应用程序中创建spider.py,在其中定义两个蜘蛛,继承您之前编写的蜘蛛,然后添加存储方法

bashvim ~/python_spider/web/spider.py

代码如下:

python# -*- coding: utf-8 -*-

from sfspider import spider

from web.models import Answer, Question, Tag

class ContentSpider(spider.SegmentfaultQuestionSpider):

def save(self): # 添加save()方法

sf_id = self.url.split('/')[-1] # 1

tags = [Tag.objects.get_or_create(title=tag_title)[0] for tag_title in self.tags] # 2

question, created = Question.objects.get_or_create(

sf_id=sf_id,

defaults={'title':self.title, 'content':self.content}

) # 3

question.tags.add(*tags) # 4

question.save()

for answer in self.answers:

Answer.objects.get_or_create(content=answer, question=question)

return question, created

class TagSpider(spider.SegmentfaultTagSpider):

def crawl(self): # 采集当前分页

sf_ids = [url.split('/')[-1] for url in self.questions]

for sf_id in sf_ids:

question, created = ContentSpider(sf_id).save()

def crawl_all_pages(self):

while True:

print u'正在抓取TAG:%s, 分页:%s' % (self.tag_name, self.page) # 5

self.crawl()

if not self.has_next_page:

break

else:

self.next_page()

这个地方很蠢。您应该先将此属性添加到SegmentfaultQuestionSpider。创建或获取问题的标签创建或获取问题,使用sf_id避免重复向问题添加标签,此处使用*是因为此方法的原创参数为(tag1,tag2,tag3)。但是我们的标签是一个方便的方法,可以在测试列表后查看进度

然后,测试我们的仓储脚本

bashpython manage.py shell

python>>> from web.spider import TagSpider

>>> t = TagSpider(u'微信')

>>> t.crawl_all_pages()

正在抓取TAG:微信, 分页:1

正在抓取TAG:微信, 分页:2

正在抓取TAG:微信, 分页:3

KeyboardInterrupt # 用control-c中断运行,测试一下就行:)

>>> from web.models import Tag, Question

>>> Question.objects.all()

[, , , , , , , , , , , , , , , , , , , , '...(remaining elements truncated)...']

>>> Question.objects.get(pk=5).tags.all() # 数据库中id=5的question的tags

[, , , ]

3.3设置django.contrib.admin以查看和编辑内容

为了更直观地观察我的采集数据,我可以使用django随附的admin

编辑文件

bashvim ~/python_spider/web/admin.py

pythonfrom django.contrib import admin

from web.models import Tag, Question, Answer

admin.site.register(Tag)

admin.site.register(Question)

admin.site.register(Answer)

然后创建一个超级用户

bashpython manage.py createsuperuser # 根据提示创建

启动测试服务器

bashpython manage.py runserver 0.0.0.0:80 # 我这是在runabove上,本地直接manage.py runserver

然后,我登录到刚创建的帐户,然后可以查看和编辑内容。

好,就是今天的内容,

下一篇文章是编写django视图并应用简单的模板来构建网站。

解读:采集站也能解决收录问题(实例操作)

采集交流 • 优采云 发表了文章 • 0 个评论 • 429 次浏览 • 2020-09-06 15:26

今天,大兵先生将与您分享:提高网站 收录技能。我相信每个人在进行SEO优化时都会遇到两种情况:网站内容为采集,搜索引擎没有收录或显然他是原创,他的内容不是收录,采集他的[ 网站内容网站实际上具有排名。接下来,Daring先生将分享如何解决网站 收录问题。

首先让我们看一下这个案例。 网站 文章全部为采集,不仅是收录,权重也是7。

/ EP6XcUHSJ6feZgOytGGylrw(QR码的自动识别)

为什么桩号采集有这种效果,桩号采集如何有收录?我们需要找到搜索引擎来识别内容模式,包括蜘蛛挖掘,发现以及如何决定是否收录您的页面。

首先查看蜘蛛的挖掘和发现:搜索引擎在寻找内容时,它们会根据URL特征找到您的内容,同时,使用标题来挖掘信息以查找搜索引擎所需要的内容需求。

蜘蛛程序的任务是不断找到需要的内容。蜘蛛会定期挖掘您的网站信息。这个规则是什么样的?规则是您的URL构成特征,即使您为采集,URL也可以形成特征。搜索引擎使用批处理级别的爬网。这是一个常规URL。当您的URL具有此类规则时,爬虫将抓取此类页面,例如1. html。如果页面质量更好,则爬虫将从顶部开始,从底部开始,将2. html 3. html等批量下载到他的数据库中。

是真的吗?让我们通过网站日志进行验证:将其打开,如果对日志进行了分析的学生发现,当搜索引擎在某个目录或类别中获取信息时,它将始终获取该类别的内容。在同一类别中,页面URL是否正常?同一目录中页面的URL当然是常规的。这是否验证了我们先前的分析? URL必须是常规的。

因此每个人都记得优化URL分类非常重要,并且这是影响收录的很大因素,因为搜索引擎以后可以直接通过网站特性直接抓取您的内容。因此,优化的不是内容,而是网页框架的功能优化。

<p>除了URL功能爬网之外,搜索引擎还将执行实例爬网。查看以下两个标题,并观察两者之间的关系,是否只是产品名称不同,而其他单词是否相同。综上所述,在产品分类下,标题规则是[*] _ Price_Picture_Brand_How-Jingdong Mall,此窍门是:实现标题与URL的统一关系,方便搜索引擎直接抓取您的信息。 查看全部

采集站也可以解决收录问题(示例操作)

今天,大兵先生将与您分享:提高网站 收录技能。我相信每个人在进行SEO优化时都会遇到两种情况:网站内容为采集,搜索引擎没有收录或显然他是原创,他的内容不是收录,采集他的[ 网站内容网站实际上具有排名。接下来,Daring先生将分享如何解决网站 收录问题。

首先让我们看一下这个案例。 网站 文章全部为采集,不仅是收录,权重也是7。

/ EP6XcUHSJ6feZgOytGGylrw(QR码的自动识别)

为什么桩号采集有这种效果,桩号采集如何有收录?我们需要找到搜索引擎来识别内容模式,包括蜘蛛挖掘,发现以及如何决定是否收录您的页面。

首先查看蜘蛛的挖掘和发现:搜索引擎在寻找内容时,它们会根据URL特征找到您的内容,同时,使用标题来挖掘信息以查找搜索引擎所需要的内容需求。

蜘蛛程序的任务是不断找到需要的内容。蜘蛛会定期挖掘您的网站信息。这个规则是什么样的?规则是您的URL构成特征,即使您为采集,URL也可以形成特征。搜索引擎使用批处理级别的爬网。这是一个常规URL。当您的URL具有此类规则时,爬虫将抓取此类页面,例如1. html。如果页面质量更好,则爬虫将从顶部开始,从底部开始,将2. html 3. html等批量下载到他的数据库中。

是真的吗?让我们通过网站日志进行验证:将其打开,如果对日志进行了分析的学生发现,当搜索引擎在某个目录或类别中获取信息时,它将始终获取该类别的内容。在同一类别中,页面URL是否正常?同一目录中页面的URL当然是常规的。这是否验证了我们先前的分析? URL必须是常规的。

因此每个人都记得优化URL分类非常重要,并且这是影响收录的很大因素,因为搜索引擎以后可以直接通过网站特性直接抓取您的内容。因此,优化的不是内容,而是网页框架的功能优化。

<p>除了URL功能爬网之外,搜索引擎还将执行实例爬网。查看以下两个标题,并观察两者之间的关系,是否只是产品名称不同,而其他单词是否相同。综上所述,在产品分类下,标题规则是[*] _ Price_Picture_Brand_How-Jingdong Mall,此窍门是:实现标题与URL的统一关系,方便搜索引擎直接抓取您的信息。

解决方案:u采 采集 用户特点

采集交流 • 优采云 发表了文章 • 0 个评论 • 357 次浏览 • 2020-09-05 06:14

Internet应用程序

随着Internet的发展和普及,Internet用户迅速增长,Internet已成为人们生活中的日常内容。人们使用网站进行阅读,发布,搜索,交流,购物等,所有这些在线行为,从点到点,都会产生巨大的商业价值。因此,互联网已成为许多人的梦想帝国,也是渴望淘金的地方。无论您是富人还是身无分文,这里只有信息为王,服务至上。因此,信息的创建,采集,组织和重新处理是网站的基础。信息采集系统可以通过网站管理员指定的网站地址和预定义的爬网规则自动获取Web内容,并根据其网站系统自身的数据结构自动提取数据并将其发布到网站,在系统中,您可以使网站在一夜之间捕获世界,而无需花费任何精力和金钱。

信息搜索

由于各种用户组之间的网络连接,Internet已成为一个无所不包的信息数据库。商业,学术和个人信息可以在Internet上发布和获取。因此,企业可以通过Internet获得客户资源。 ,市场条件,业务信息等),但是在这浩如烟海的信息中,我们经常缺少一种工具来发现我们关心的内容,并有效地组织和保留它们以使其成为企业的内部资源。信息采集系统可以根据数据模式通过搜索引擎自动检索数据,并在桌面上显示匹配的信息。

数据输入

企业管理系统,企业信息管理系统,客户服务系统和其他信息处理系统只能处理结构化数据。例如,学生信息包括诸如用户名,性别和年龄的属性。它们必须存储在预定义的结构中。但是,系统外部将存在大量非结构化数据,例如客户提交的材料和公司内部文档。这些数据通常是手动计数的,并手动输入到各种信息处理系统中。信息采集系统可以根据信息系统的数据结构自动将文档提取到多个字段中,并将这些字段自动导入到企业的各种信息处理系统中。 查看全部

uCai 采集用户功能

Internet应用程序

随着Internet的发展和普及,Internet用户迅速增长,Internet已成为人们生活中的日常内容。人们使用网站进行阅读,发布,搜索,交流,购物等,所有这些在线行为,从点到点,都会产生巨大的商业价值。因此,互联网已成为许多人的梦想帝国,也是渴望淘金的地方。无论您是富人还是身无分文,这里只有信息为王,服务至上。因此,信息的创建,采集,组织和重新处理是网站的基础。信息采集系统可以通过网站管理员指定的网站地址和预定义的爬网规则自动获取Web内容,并根据其网站系统自身的数据结构自动提取数据并将其发布到网站,在系统中,您可以使网站在一夜之间捕获世界,而无需花费任何精力和金钱。

信息搜索

由于各种用户组之间的网络连接,Internet已成为一个无所不包的信息数据库。商业,学术和个人信息可以在Internet上发布和获取。因此,企业可以通过Internet获得客户资源。 ,市场条件,业务信息等),但是在这浩如烟海的信息中,我们经常缺少一种工具来发现我们关心的内容,并有效地组织和保留它们以使其成为企业的内部资源。信息采集系统可以根据数据模式通过搜索引擎自动检索数据,并在桌面上显示匹配的信息。

数据输入

企业管理系统,企业信息管理系统,客户服务系统和其他信息处理系统只能处理结构化数据。例如,学生信息包括诸如用户名,性别和年龄的属性。它们必须存储在预定义的结构中。但是,系统外部将存在大量非结构化数据,例如客户提交的材料和公司内部文档。这些数据通常是手动计数的,并手动输入到各种信息处理系统中。信息采集系统可以根据信息系统的数据结构自动将文档提取到多个字段中,并将这些字段自动导入到企业的各种信息处理系统中。

采采系列之采集数据处理大师

采集交流 • 优采云 发表了文章 • 0 个评论 • 298 次浏览 • 2020-08-26 05:34

采采系列之采集数据处理大师,与之配合的一有系列的软件,如邮箱采集,手机号码采集,邮箱注册等.

采采系列之采集数据处理大师主要功能:

1、利用辞典对内容进行伪原创处理,可以是数据表里的一个或多个数组;

2、繁简互换,并对一些非常词汇进行处理,如:鼠标《-》滑鼠;程序《-》程式;网络《-》网路;

3、利用Google及Bing提供的API把英文内容翻译成英文(至于可读程度本程序无能为力);

4、定时启动优采云采集程序采集,目前只可以控件到每位站点,尚不能有效到每位任务;

5、各辞典编辑功能

6、多数据库支持,目前支持MS SQL、SQLite、MySQL、Access

采采系列之采集数据处理大师2012年12月份修改

1、增加动词及提取描述功能

2、增加添加自定义关键字功能(可以限定次数)

3、增加添加自定义链接功能(可以限定次数)

4、增加有道翻译引擎

5、增加更多的翻译语言选项

6、增加搅乱文章段落次序功能

7、增加给关键字加链接功能

8、增加在文字内容前或文字内容后加上自己定义内容功能

9、增加多内容合并功能

10、增加数据浏览中的网页浏览方式

11、增加任务执行中停止任务功能

12、去掉定时采集功能(个中缘由不解释)

13、增加了进度条显示

14、用多线程执行任务,程序不再卡顿,但由于涉及到数据处理,处理数据时还是单线程,主要是为了数据安全考虑 查看全部

采采系列之采集数据处理大师

采采系列之采集数据处理大师,与之配合的一有系列的软件,如邮箱采集,手机号码采集,邮箱注册等.

采采系列之采集数据处理大师主要功能:

1、利用辞典对内容进行伪原创处理,可以是数据表里的一个或多个数组;

2、繁简互换,并对一些非常词汇进行处理,如:鼠标《-》滑鼠;程序《-》程式;网络《-》网路;

3、利用Google及Bing提供的API把英文内容翻译成英文(至于可读程度本程序无能为力);

4、定时启动优采云采集程序采集,目前只可以控件到每位站点,尚不能有效到每位任务;

5、各辞典编辑功能

6、多数据库支持,目前支持MS SQL、SQLite、MySQL、Access

采采系列之采集数据处理大师2012年12月份修改

1、增加动词及提取描述功能

2、增加添加自定义关键字功能(可以限定次数)

3、增加添加自定义链接功能(可以限定次数)

4、增加有道翻译引擎

5、增加更多的翻译语言选项

6、增加搅乱文章段落次序功能

7、增加给关键字加链接功能

8、增加在文字内容前或文字内容后加上自己定义内容功能

9、增加多内容合并功能

10、增加数据浏览中的网页浏览方式

11、增加任务执行中停止任务功能

12、去掉定时采集功能(个中缘由不解释)

13、增加了进度条显示

14、用多线程执行任务,程序不再卡顿,但由于涉及到数据处理,处理数据时还是单线程,主要是为了数据安全考虑

微服务构架下的监控系统设计(一)——指标数据的采集展示

采集交流 • 优采云 发表了文章 • 0 个评论 • 328 次浏览 • 2020-08-19 20:22

前言

微服务是一种构架风格,一个小型复杂软件应用一般由多个微服务组成。系统中的各个微服务可被独立布署,各个微服务之间是松耦合的。每个微服务仅关注于完成一件任务并挺好地完成该任务。

微服务之前好多单体应用,其监控复杂度较低,场景也比较单一。微服务下,由于业务逻辑散播在诸多进程中(很多小型业务,一个业务流程涉及的服务有几十个),一旦业务出现问题,追查其源头就好比大海捞针,这个时侯就须要建立的监控体系。

一个建立的监控体系,其建立周期比较漫长,而且随着业务场景的变化,自身也是须要不断迭代优化的。本文仅从几个监控维度以及原子化场景说说怎么构建统一的监控数据搜集、展示系统,希望就能启发你们继续深入地思索监控体系的建设。

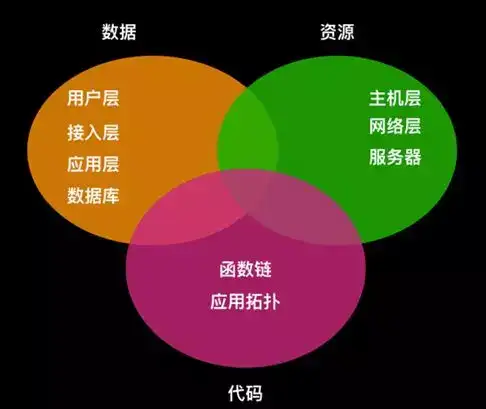

微服务下的几个监控维度

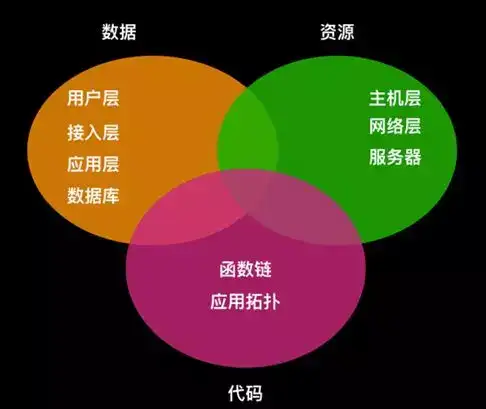

微服务监控与传统应用的监控相比,最显著的改变就是视角的改变,我们把监控从机器视角转换成以服务为中心的视角,在微服务的视角下,监控可以从数据维度、资源维度和代码维度进行分层,如下图:

数据维度

当前WEB化服务是主流,每一个WEB服务都有一个入口,不管是APP还是WEB网页,入口负责跟用户交互,并将用户的信息发给后台,后台通常还会有接入LB或则Gateway,负责负载均衡并将数据转发给具体的应用处理,最后由应用处理过后写入数据库。

资源维度

现在好多服务布署在云端,涉及虚拟化技术,虚拟主机运行在数学服务器上,虚拟主机之间通过虚拟网路互相联接。在资源层面的监控,是不可缺乏的一环,我们不但须要采集虚拟主机的性能指标,同时还须要晓得运行虚拟主机的服务器上的CPU、内存、磁盘IO等数据,以及联接虚拟主机之间的虚拟网路的带宽负载等。

代码维度

APM,也就是应用性能剖析,代码侧的监控采集,是随着微服务的盛行而出现的。在微服务场景下,一个业务流程横越几十个服务的场景,只有传统的监控数据,很难定位到问题的症结。

我们可以针对代码的技术栈,开发出特定的采集框架,在性能耗损可以接受的范围之内,采集函数之间的调用关系,服务之间的调用拓扑,并检测函数或则服务的响应时间,才能有针对性地优化性能或则提早预判故障。

关键监控指标的场景描述

微服务监控最大的特性,用一句话概括:就是服务非常多,服务间的调用也十分复杂。当系统出现问题时,想要在上百个相关的、依赖错综复杂的服务系统之中快速定位到出错的系统,需要借助关键的监控指标。我们在上述的三个维度之上,分析了每位维度下每位层级可能会形成的告警情况,总结了URL监控、主机监控、产品监控等八个原子化监控场景。

URL监控:无论是APP还是WEB,本质上都是通过URL发起后台调用,可以通过MOCK调用API获取响应时间、响应状态码等指标,展示检测业务的整体健康状况。

主机监控:通过安装代理采集主机上基本的监控信息如CPU、内存、IO等数据,同时用户可以通过配置文件打开其它开源应用如Tomcat、Nginx等数据采集开关。

产品监控:公有云将主机、网络、存储以及一些中间件以产品的方式提供给用户使用,产品服务后台上报各个产品相关指标数据,用来监控各个产品资源的健康状况。

组件监控:一些开源组件,比如Tomcat、Nginx、Netty等监控数据的采集,可以通过主机上的代理加载相应组件的监控采集程序。

自定义监控:服务实例搜集业务相关数据,定时调用API插口上报数据,支持多个服务实例同时上报一个监控项,并且支持多维度查询告警。

资源监控:用户以资源为维度上报自定义数据,每个资源都有相同的几个监控项,各个资源的监控项之间互相独立。

APM:根据各语言栈的不同,分别实现函数调用关系、服务之间调用拓扑的展示。根据各个语言的不同,有的须要入侵代码,以SDK嵌入的方式搜集数据,有的则与代码前馈,通过元编程重载一些方式来实现数据采集。

事件监控:针对公有云产品、业务逻辑中的不连续风波,比如网盘的不可用风波、SSD硬盘的Reset风波等,提供统一的储存、分析、展示。

有了以上原子化场景的数据搜集,我们就可以通过UI统一展示监控数据,可以根据前文描述的三个维度,以用户体验为核心,设计图形化页面。图形化通常是以时间序列为纵轴,展示指标随时间变化,针对一些统计指标,也可以通过饼图、柱状图等展示剖析、对比结果。

本文主要探讨了监控体系中数据的采集、展示。至于数据的储存及告警流程,有兴趣的朋友可以继续关注后续监控相关文章。

作者介绍

董磊:UCloud技术专家。十年IT行业开发经验,目前负责UCloud混和云、监控产品的设计开发,持续关注微服务构架、监控、DevOps等领域。

*更多技术干货,欢迎陌陌关注“UCloud技术公告牌”查看。 查看全部

微服务构架下的监控系统设计(一)——指标数据的采集展示

前言

微服务是一种构架风格,一个小型复杂软件应用一般由多个微服务组成。系统中的各个微服务可被独立布署,各个微服务之间是松耦合的。每个微服务仅关注于完成一件任务并挺好地完成该任务。

微服务之前好多单体应用,其监控复杂度较低,场景也比较单一。微服务下,由于业务逻辑散播在诸多进程中(很多小型业务,一个业务流程涉及的服务有几十个),一旦业务出现问题,追查其源头就好比大海捞针,这个时侯就须要建立的监控体系。

一个建立的监控体系,其建立周期比较漫长,而且随着业务场景的变化,自身也是须要不断迭代优化的。本文仅从几个监控维度以及原子化场景说说怎么构建统一的监控数据搜集、展示系统,希望就能启发你们继续深入地思索监控体系的建设。

微服务下的几个监控维度

微服务监控与传统应用的监控相比,最显著的改变就是视角的改变,我们把监控从机器视角转换成以服务为中心的视角,在微服务的视角下,监控可以从数据维度、资源维度和代码维度进行分层,如下图:

数据维度

当前WEB化服务是主流,每一个WEB服务都有一个入口,不管是APP还是WEB网页,入口负责跟用户交互,并将用户的信息发给后台,后台通常还会有接入LB或则Gateway,负责负载均衡并将数据转发给具体的应用处理,最后由应用处理过后写入数据库。

资源维度

现在好多服务布署在云端,涉及虚拟化技术,虚拟主机运行在数学服务器上,虚拟主机之间通过虚拟网路互相联接。在资源层面的监控,是不可缺乏的一环,我们不但须要采集虚拟主机的性能指标,同时还须要晓得运行虚拟主机的服务器上的CPU、内存、磁盘IO等数据,以及联接虚拟主机之间的虚拟网路的带宽负载等。

代码维度

APM,也就是应用性能剖析,代码侧的监控采集,是随着微服务的盛行而出现的。在微服务场景下,一个业务流程横越几十个服务的场景,只有传统的监控数据,很难定位到问题的症结。

我们可以针对代码的技术栈,开发出特定的采集框架,在性能耗损可以接受的范围之内,采集函数之间的调用关系,服务之间的调用拓扑,并检测函数或则服务的响应时间,才能有针对性地优化性能或则提早预判故障。

关键监控指标的场景描述

微服务监控最大的特性,用一句话概括:就是服务非常多,服务间的调用也十分复杂。当系统出现问题时,想要在上百个相关的、依赖错综复杂的服务系统之中快速定位到出错的系统,需要借助关键的监控指标。我们在上述的三个维度之上,分析了每位维度下每位层级可能会形成的告警情况,总结了URL监控、主机监控、产品监控等八个原子化监控场景。

URL监控:无论是APP还是WEB,本质上都是通过URL发起后台调用,可以通过MOCK调用API获取响应时间、响应状态码等指标,展示检测业务的整体健康状况。

主机监控:通过安装代理采集主机上基本的监控信息如CPU、内存、IO等数据,同时用户可以通过配置文件打开其它开源应用如Tomcat、Nginx等数据采集开关。

产品监控:公有云将主机、网络、存储以及一些中间件以产品的方式提供给用户使用,产品服务后台上报各个产品相关指标数据,用来监控各个产品资源的健康状况。

组件监控:一些开源组件,比如Tomcat、Nginx、Netty等监控数据的采集,可以通过主机上的代理加载相应组件的监控采集程序。

自定义监控:服务实例搜集业务相关数据,定时调用API插口上报数据,支持多个服务实例同时上报一个监控项,并且支持多维度查询告警。

资源监控:用户以资源为维度上报自定义数据,每个资源都有相同的几个监控项,各个资源的监控项之间互相独立。

APM:根据各语言栈的不同,分别实现函数调用关系、服务之间调用拓扑的展示。根据各个语言的不同,有的须要入侵代码,以SDK嵌入的方式搜集数据,有的则与代码前馈,通过元编程重载一些方式来实现数据采集。

事件监控:针对公有云产品、业务逻辑中的不连续风波,比如网盘的不可用风波、SSD硬盘的Reset风波等,提供统一的储存、分析、展示。

有了以上原子化场景的数据搜集,我们就可以通过UI统一展示监控数据,可以根据前文描述的三个维度,以用户体验为核心,设计图形化页面。图形化通常是以时间序列为纵轴,展示指标随时间变化,针对一些统计指标,也可以通过饼图、柱状图等展示剖析、对比结果。

本文主要探讨了监控体系中数据的采集、展示。至于数据的储存及告警流程,有兴趣的朋友可以继续关注后续监控相关文章。

作者介绍

董磊:UCloud技术专家。十年IT行业开发经验,目前负责UCloud混和云、监控产品的设计开发,持续关注微服务构架、监控、DevOps等领域。

*更多技术干货,欢迎陌陌关注“UCloud技术公告牌”查看。

微服务构架下的监控系统设计(一)——指标数据的采集展示 UCloud云计算

采集交流 • 优采云 发表了文章 • 0 个评论 • 341 次浏览 • 2020-08-18 19:14

前言

微服务是一种构架风格,一个小型复杂软件应用一般由多个微服务组成。系统中的各个微服务可被独立布署,各个微服务之间是松耦合的。每个微服务仅关注于完成一件任务并挺好地完成该任务。

微服务之前好多单体应用,其监控复杂度较低,场景也比较单一。微服务下,由于业务逻辑散播在诸多进程中(很多小型业务,一个业务流程涉及的服务有几十个),一旦业务出现问题,追查其源头就好比大海捞针,这个时侯就须要建立的监控体系。

一个建立的监控体系,其建立周期比较漫长,而且随着业务场景的变化,自身也是须要不断迭代优化的。本文仅从几个监控维度以及原子化场景说说怎么构建统一的监控数据搜集、展示系统,希望就能启发你们继续深入地思索监控体系的建设。

微服务下的几个监控维度

微服务监控与传统应用的监控相比,最显著的改变就是视角的改变,我们把监控从机器视角转换成以服务为中心的视角,在微服务的视角下,监控可以从数据维度、资源维度和代码维度进行分层,如下图:

数据维度

当前WEB化服务是主流,每一个WEB服务都有一个入口,不管是APP还是WEB网页,入口负责跟用户交互,并将用户的信息发给后台,后台通常还会有接入LB或则Gateway,负责负载均衡并将数据转发给具体的应用处理,最后由应用处理过后写入数据库。

资源维度

现在好多服务布署在云端,涉及虚拟化技术,虚拟主机运行在数学服务器上,虚拟主机之间通过虚拟网路互相联接。在资源层面的监控,是不可缺乏的一环,我们不但须要采集虚拟主机的性能指标,同时还须要晓得运行虚拟主机的服务器上的CPU、内存、磁盘IO等数据,以及联接虚拟主机之间的虚拟网路的带宽负载等。

代码维度

APM,也就是应用性能剖析,代码侧的监控采集,是随着微服务的盛行而出现的。在微服务场景下,一个业务流程横越几十个服务的场景,只有传统的监控数据,很难定位到问题的症结。

我们可以针对代码的技术栈,开发出特定的采集框架,在性能耗损可以接受的范围之内,采集函数之间的调用关系,服务之间的调用拓扑,并检测函数或则服务的响应时间,才能有针对性地优化性能或则提早预判故障。

关键监控指标的场景描述

微服务监控最大的特性,用一句话概括:就是服务非常多,服务间的调用也十分复杂。当系统出现问题时,想要在上百个相关的、依赖错综复杂的服务系统之中快速定位到出错的系统,需要借助关键的监控指标。我们在上述的三个维度之上,分析了每位维度下每位层级可能会形成的告警情况,总结了URL监控、主机监控、产品监控等八个原子化监控场景。

URL监控: 无论是APP还是WEB,本质上都是通过URL发起后台调用,可以通过MOCK调用API获取响应时间、响应状态码等指标,展示检测业务的整体健康状况。

主机监控: 通过安装代理采集主机上基本的监控信息如CPU、内存、IO等数据,同时用户可以通过配置文件打开其它开源应用如Tomcat、Nginx等数据采集开关。

产品监控: 公有云将主机、网络、存储以及一些中间件以产品的方式提供给用户使用,产品服务后台上报各个产品相关指标数据,用来监控各个产品资源的健康状况。

组件监控: 一些开源组件,比如Tomcat、Nginx、Netty等监控数据的采集,可以通过主机上的代理加载相应组件的监控采集程序。

自定义监控: 服务实例搜集业务相关数据,定时调用API插口上报数据,支持多个服务实例同时上报一个监控项,并且支持多维度查询告警。

资源监控: 用户以资源为维度上报自定义数据,每个资源都有相同的几个监控项,各个资源的监控项之间互相独立。

APM: 根据各语言栈的不同,分别实现函数调用关系、服务之间调用拓扑的展示。根据各个语言的不同,有的须要入侵代码,以SDK嵌入的方式搜集数据,有的则与代码前馈,通过元编程重载一些方式来实现数据采集。

事件监控: 针对公有云产品、业务逻辑中的不连续风波,比如网盘的不可用风波、SSD硬盘的Reset风波等,提供统一的储存、分析、展示。

有了以上原子化场景的数据搜集,我们就可以通过UI统一展示监控数据,可以根据前文描述的三个维度,以用户体验为核心,设计图形化页面。图形化通常是以时间序列为纵轴,展示指标随时间变化,针对一些统计指标,也可以通过饼图、柱状图等展示剖析、对比结果。

本文主要探讨了监控体系中数据的采集、展示。至于数据的储存及告警流程,有兴趣的朋友可以继续关注后续监控相关文章。

作者介绍

董磊:UCloud技术专家。十年IT行业开发经验,目前负责UCloud混和云、监控产品的设计开发,持续关注微服务构架、监控、DevOps等领域。

更多技术干货,欢迎陌陌关注 “UCloud技术公告牌” 查看。 查看全部

微服务构架下的监控系统设计(一)——指标数据的采集展示 UCloud云计算

前言

微服务是一种构架风格,一个小型复杂软件应用一般由多个微服务组成。系统中的各个微服务可被独立布署,各个微服务之间是松耦合的。每个微服务仅关注于完成一件任务并挺好地完成该任务。

微服务之前好多单体应用,其监控复杂度较低,场景也比较单一。微服务下,由于业务逻辑散播在诸多进程中(很多小型业务,一个业务流程涉及的服务有几十个),一旦业务出现问题,追查其源头就好比大海捞针,这个时侯就须要建立的监控体系。

一个建立的监控体系,其建立周期比较漫长,而且随着业务场景的变化,自身也是须要不断迭代优化的。本文仅从几个监控维度以及原子化场景说说怎么构建统一的监控数据搜集、展示系统,希望就能启发你们继续深入地思索监控体系的建设。

微服务下的几个监控维度

微服务监控与传统应用的监控相比,最显著的改变就是视角的改变,我们把监控从机器视角转换成以服务为中心的视角,在微服务的视角下,监控可以从数据维度、资源维度和代码维度进行分层,如下图:

数据维度

当前WEB化服务是主流,每一个WEB服务都有一个入口,不管是APP还是WEB网页,入口负责跟用户交互,并将用户的信息发给后台,后台通常还会有接入LB或则Gateway,负责负载均衡并将数据转发给具体的应用处理,最后由应用处理过后写入数据库。

资源维度

现在好多服务布署在云端,涉及虚拟化技术,虚拟主机运行在数学服务器上,虚拟主机之间通过虚拟网路互相联接。在资源层面的监控,是不可缺乏的一环,我们不但须要采集虚拟主机的性能指标,同时还须要晓得运行虚拟主机的服务器上的CPU、内存、磁盘IO等数据,以及联接虚拟主机之间的虚拟网路的带宽负载等。

代码维度

APM,也就是应用性能剖析,代码侧的监控采集,是随着微服务的盛行而出现的。在微服务场景下,一个业务流程横越几十个服务的场景,只有传统的监控数据,很难定位到问题的症结。

我们可以针对代码的技术栈,开发出特定的采集框架,在性能耗损可以接受的范围之内,采集函数之间的调用关系,服务之间的调用拓扑,并检测函数或则服务的响应时间,才能有针对性地优化性能或则提早预判故障。

关键监控指标的场景描述

微服务监控最大的特性,用一句话概括:就是服务非常多,服务间的调用也十分复杂。当系统出现问题时,想要在上百个相关的、依赖错综复杂的服务系统之中快速定位到出错的系统,需要借助关键的监控指标。我们在上述的三个维度之上,分析了每位维度下每位层级可能会形成的告警情况,总结了URL监控、主机监控、产品监控等八个原子化监控场景。

URL监控: 无论是APP还是WEB,本质上都是通过URL发起后台调用,可以通过MOCK调用API获取响应时间、响应状态码等指标,展示检测业务的整体健康状况。

主机监控: 通过安装代理采集主机上基本的监控信息如CPU、内存、IO等数据,同时用户可以通过配置文件打开其它开源应用如Tomcat、Nginx等数据采集开关。

产品监控: 公有云将主机、网络、存储以及一些中间件以产品的方式提供给用户使用,产品服务后台上报各个产品相关指标数据,用来监控各个产品资源的健康状况。

组件监控: 一些开源组件,比如Tomcat、Nginx、Netty等监控数据的采集,可以通过主机上的代理加载相应组件的监控采集程序。

自定义监控: 服务实例搜集业务相关数据,定时调用API插口上报数据,支持多个服务实例同时上报一个监控项,并且支持多维度查询告警。

资源监控: 用户以资源为维度上报自定义数据,每个资源都有相同的几个监控项,各个资源的监控项之间互相独立。

APM: 根据各语言栈的不同,分别实现函数调用关系、服务之间调用拓扑的展示。根据各个语言的不同,有的须要入侵代码,以SDK嵌入的方式搜集数据,有的则与代码前馈,通过元编程重载一些方式来实现数据采集。

事件监控: 针对公有云产品、业务逻辑中的不连续风波,比如网盘的不可用风波、SSD硬盘的Reset风波等,提供统一的储存、分析、展示。

有了以上原子化场景的数据搜集,我们就可以通过UI统一展示监控数据,可以根据前文描述的三个维度,以用户体验为核心,设计图形化页面。图形化通常是以时间序列为纵轴,展示指标随时间变化,针对一些统计指标,也可以通过饼图、柱状图等展示剖析、对比结果。

本文主要探讨了监控体系中数据的采集、展示。至于数据的储存及告警流程,有兴趣的朋友可以继续关注后续监控相关文章。

作者介绍

董磊:UCloud技术专家。十年IT行业开发经验,目前负责UCloud混和云、监控产品的设计开发,持续关注微服务构架、监控、DevOps等领域。

更多技术干货,欢迎陌陌关注 “UCloud技术公告牌” 查看。

基于Kafka的服务端用户行为日志采集

采集交流 • 优采云 发表了文章 • 0 个评论 • 732 次浏览 • 2020-08-18 06:12

本文来自网易云社区

作者:李勇

背景

随着互联网的不断发展,用户所形成的行为数据被越来越多的网站重视,那么哪些是用户行为呢?所谓的用户行为主要由五种元素组成:时间、地点、人物、行为、行为对应的内容。为什么要做用户的行为剖析?因为只有做了用户行为剖析能够晓得用户画像、才能晓得用户在网站上的各类浏览、点击、购买背后的商业真相,从而给企业带来商业价值。

网易美学是一个供用户发觉和分享美妆及化妆的社区。既然是一个社区,其中的用户行为剖析饰演着举足轻重的角色。对应网易美学来说,用户行为主要有以下几个应用场景:

埋点技术

用户的行为对于一个互联网产品来说很重要,因此怎么采集用户的行为就显得十分至关重要了。对用户的行为采集可以通过埋点的方法实现,埋点主要有以下几种形式:

服务端日志采集

下面我详尽介绍下网易美学的服务端日志采集系统使用的技术,总体构架,部署图,运作流程以及配置相关信息。

1.技术选型

服务端日志采集主要通过在Controller的插口中进行埋点,然后通过AOP技术、Kafka消息系统以及logback对用户行为进行采集。

之所以使用AOP技术是因为AOP的以下重要特定:

由于使用异步方法对用户行为信息进行搜集,因此须要使用消息中间件。目前消息中间件特别多,比较流行的有ActiveMQ、ZeroMQ、RabbitMQ、Kafka等。每个消息中间件都有各类的优势劣势,之所以使用Kafka消息中间件,是因为以下几点诱因:

因为用户的行为数据最终是以日志的方式持久化的,因此使用logback对日志持久化到日志服务器中。

2.总体构架

图1总体构架图

服务端日志采集系统主要由两个工程组成:beauty-bi-core和beauty-bi-service。由于网易美学的使用dubbo框架,因此有服务提供方和服务消费方。beauty-bi-core被web、wap和mainsite服务消费方依赖。此外,beauty-bi-service也依赖于beauty-bi-core,主要是依赖于其中的一些实体类及工具类。

beauty-bi-core工程为Kafka消息的生产者,主要封装实现切面的具体逻辑,其主要职责如下:

beauty-bi-service工程为Kafka消息的消费者,其主要职责如下:

3.部署图

图2部署图

上图为网易美学与日志系统系统相关的布署图,App、Wap和Mainsite服务器集群分别对应不同终端的应用。Kafka集群使用杭研的集群,目前有10个Broker。日志服务器有两台,通过Kafka的均衡策略对日志进行消费。

4.日志采集的流程

日志采集流程图如下所示:

图3日志打点流程图

上图为消息生产者和消息消费者共同组成的流程图。

消息生产者的具体步骤如下:

消息消费者的具体步骤如下:

5.相关配置

网易云大礼包:

本文来自网易云社区,经作者勇授权发布。

相关文章:

【推荐】3分钟把握一个有数小技能:制作动态标题 查看全部

基于Kafka的服务端用户行为日志采集

本文来自网易云社区

作者:李勇

背景

随着互联网的不断发展,用户所形成的行为数据被越来越多的网站重视,那么哪些是用户行为呢?所谓的用户行为主要由五种元素组成:时间、地点、人物、行为、行为对应的内容。为什么要做用户的行为剖析?因为只有做了用户行为剖析能够晓得用户画像、才能晓得用户在网站上的各类浏览、点击、购买背后的商业真相,从而给企业带来商业价值。

网易美学是一个供用户发觉和分享美妆及化妆的社区。既然是一个社区,其中的用户行为剖析饰演着举足轻重的角色。对应网易美学来说,用户行为主要有以下几个应用场景:

埋点技术

用户的行为对于一个互联网产品来说很重要,因此怎么采集用户的行为就显得十分至关重要了。对用户的行为采集可以通过埋点的方法实现,埋点主要有以下几种形式:

服务端日志采集

下面我详尽介绍下网易美学的服务端日志采集系统使用的技术,总体构架,部署图,运作流程以及配置相关信息。

1.技术选型

服务端日志采集主要通过在Controller的插口中进行埋点,然后通过AOP技术、Kafka消息系统以及logback对用户行为进行采集。

之所以使用AOP技术是因为AOP的以下重要特定:

由于使用异步方法对用户行为信息进行搜集,因此须要使用消息中间件。目前消息中间件特别多,比较流行的有ActiveMQ、ZeroMQ、RabbitMQ、Kafka等。每个消息中间件都有各类的优势劣势,之所以使用Kafka消息中间件,是因为以下几点诱因:

因为用户的行为数据最终是以日志的方式持久化的,因此使用logback对日志持久化到日志服务器中。

2.总体构架

图1总体构架图

服务端日志采集系统主要由两个工程组成:beauty-bi-core和beauty-bi-service。由于网易美学的使用dubbo框架,因此有服务提供方和服务消费方。beauty-bi-core被web、wap和mainsite服务消费方依赖。此外,beauty-bi-service也依赖于beauty-bi-core,主要是依赖于其中的一些实体类及工具类。

beauty-bi-core工程为Kafka消息的生产者,主要封装实现切面的具体逻辑,其主要职责如下:

beauty-bi-service工程为Kafka消息的消费者,其主要职责如下:

3.部署图

图2部署图

上图为网易美学与日志系统系统相关的布署图,App、Wap和Mainsite服务器集群分别对应不同终端的应用。Kafka集群使用杭研的集群,目前有10个Broker。日志服务器有两台,通过Kafka的均衡策略对日志进行消费。

4.日志采集的流程

日志采集流程图如下所示:

图3日志打点流程图

上图为消息生产者和消息消费者共同组成的流程图。

消息生产者的具体步骤如下:

消息消费者的具体步骤如下:

5.相关配置

网易云大礼包:

本文来自网易云社区,经作者勇授权发布。

相关文章:

【推荐】3分钟把握一个有数小技能:制作动态标题

用Python挖掘Twitter数据Part1:数据采集

采集交流 • 优采云 发表了文章 • 0 个评论 • 586 次浏览 • 2020-08-14 16:43

注册应用

为了才能访问Twitter数据编程,我们须要创建一个与Twitter的API交互的应用程序。

第一步是注册一个你的应用程序。值得注意的是,您须要将您的浏览器转入,登录到Twitter(如果您仍未登陆),并注册一个新的应用程序。您如今可以为您的应用程序选择一个名称和说明(例如“挖掘演示”或类似)。您将收到一个消费者秘钥和消费者密码:这些都是应用程序设置,应一直保密。在您的应用程序的配置页面,你也可以要求获取一个访问令牌和访问令牌的密码。类似于消费者秘钥,这些字符串也必须保密:他们提供的应用程序是代表您的账户访问到Twitter。默认权限是只读的,这是我们在案例中须要的,但假如你决定改变您的许可,在应用中提供修改功能,你就必须再获得一个新的访问令牌。

重要提示:使用Twitter的API时有速度限制,或者你想要提供一个可下载的数据集也会有限制,请参见:

访问数据

您可以使用Twitter提供的REST APIs与她们的服务进行交互。那里还有一群基于Python的顾客,我们可以重复循环使用。尤其Tweepy是其中最有趣和最直白的一个,所以我们一起把它安装上去:

pip install tweepy==3.3.0

更新:Tweepy发布的3.4.0版本在Python3上出现了一些问题,目前被绑定在GitHub上还不能进行使用,因此在新的版本下来之前,我们仍然使用3.3.0版本。

更多的更新:Tweepy发布的3.5.0版本早已可以使用,似乎解决了上述提及的在Python3上的问题。

为了授权我们的应用程序以代表我们访问Twitter,我们须要使用OAuth的界面:

import tweepyfrom tweepy import OAuthHandler consumer_key = ‘YOUR-CONSUMER-KEY’consumer_secret = ‘YOUR-CONSUMER-SECRET’access_token = ‘YOUR-ACCESS-TOKEN’access_secret = ‘YOUR-ACCESS-SECRET’ auth = OAuthHandler(consumer_key, consumer_secret)auth.set_access_token(access_token, access_secret) api = tweepy.API(auth)

现在的API变量是我们为可以在Twitter上执行的大多数操作的入口点。

例如,我们可以看见我们自己的时间表(或者我们的Twitter主页):

for status in tweepy.Cursor(api.home_timeline).items(10):# Process a single status print(status.text)

Tweepy提供方便的光标插口,对不同类型的对象进行迭代。在前面的事例中我们用10来限制我们正在阅读的tweets的数目,但是其实也许我们是可以访问更多的。状态变量是Status() class的一个实例,是访问数据时一个漂亮的包装。Twitter API的JSON响应在_json属性(带有前导顿号)上是可用的,它不是纯JSON字符串,而是一个字典。

所以前面的代码可以被重新写入去处理/存储JSON:

for status in tweepy.Cursor(api.home_timeline).items(10):# Process a single status process_or_store(status._json)

如果我们想要一个所有用户的名单?来这里:

for friend in tweepy.Cursor(api.friends).items(): process_or_store(friend._json)

那么我们所有的tweets的列表呢? 也很简单:

for tweet in tweepy.Cursor(api.user_timeline).items(): process_or_store(tweet._json)

通过这些方法,我们可以很容易地搜集tweets(以及更多),并将它们储存为原创的JSON格式,可以很方便的根据我们的储存格式将其转换为不同的数据模型(很多NoSQL技术提供一些批量导出功能)。

process_or_store()功能是您的自定义施行占位符。最简单的形式就是你可以只复印出JSON,每行一个tweet:

def process_or_store(tweet): print(json.dumps(tweet))

流

如果我们要“保持联接”,并搜集所有关于特定风波将会出现的tweets,流API就是我们所须要的。我们须要扩充StreamListener()来定义我们处理输入数据的形式。一个用#python hashtag搜集了所有新的tweet的事例:

from tweepy import Streamfrom tweepy.streaming import StreamListener classMyListener(StreamListener): def on_data(self, data): try: with open(‘python.json’, ‘a’) as f: f.write(data) return True except BaseException as e: print(“Error on_data: %s” % str(e)) return True def on_error(self, status): print(status) return True twitter_stream = Stream(auth, MyListener())twitter_stream.filter(track=[‘#python’])

根据不同的搜索词,我们可以在几分钟之内搜集到成千上万的tweet。世界性覆盖的现场活动尤其这么(世界杯、超级杯、奥斯卡颁奖典礼等),所以保持关注JSON文件,看看它下降的速率是多么的快,并审视你的测试可能须要多少tweet。以上脚本将把每位tweet保存在新的行中,所以你可以从Unix shell中使用wc-l python.json命令来了解到你搜集了多少tweet。

你可以在下边的要点中见到Twitter的API流的一个最小工作示例:

twitter_stream_downloader.py

总结

我们早已介绍了tweepy作为通过Python访问Twitter数据的一个相当简单的工具。我们可以按照明晰的“tweet”项目目标搜集一些不同类型的数据。

一旦我们搜集了一些数据,在剖析应用方面的就可以进行展开了。在接下来的内容中,我们将讨论部份问题。

简介:Marco Bonzanini是美国纽约的一个数据科学家。活跃于PyData社区的他喜欢从事文本剖析和数据挖掘的应用工作。他是“用Python把握社会化媒体挖掘”( 2016月7月出版)的作者。

原文链接: 查看全部

这是一系列使用Python专门用于Twitter数据挖掘的文章中的第一篇。在第一部份中,我们将见到通过不同的方法来进行Twitter的数据搜集。一旦我们构建好了一个数据集,在接下来的环节中,我们就将会讨论一些有趣的数据应用。

注册应用

为了才能访问Twitter数据编程,我们须要创建一个与Twitter的API交互的应用程序。

第一步是注册一个你的应用程序。值得注意的是,您须要将您的浏览器转入,登录到Twitter(如果您仍未登陆),并注册一个新的应用程序。您如今可以为您的应用程序选择一个名称和说明(例如“挖掘演示”或类似)。您将收到一个消费者秘钥和消费者密码:这些都是应用程序设置,应一直保密。在您的应用程序的配置页面,你也可以要求获取一个访问令牌和访问令牌的密码。类似于消费者秘钥,这些字符串也必须保密:他们提供的应用程序是代表您的账户访问到Twitter。默认权限是只读的,这是我们在案例中须要的,但假如你决定改变您的许可,在应用中提供修改功能,你就必须再获得一个新的访问令牌。

重要提示:使用Twitter的API时有速度限制,或者你想要提供一个可下载的数据集也会有限制,请参见:

访问数据

您可以使用Twitter提供的REST APIs与她们的服务进行交互。那里还有一群基于Python的顾客,我们可以重复循环使用。尤其Tweepy是其中最有趣和最直白的一个,所以我们一起把它安装上去:

pip install tweepy==3.3.0

更新:Tweepy发布的3.4.0版本在Python3上出现了一些问题,目前被绑定在GitHub上还不能进行使用,因此在新的版本下来之前,我们仍然使用3.3.0版本。

更多的更新:Tweepy发布的3.5.0版本早已可以使用,似乎解决了上述提及的在Python3上的问题。

为了授权我们的应用程序以代表我们访问Twitter,我们须要使用OAuth的界面:

import tweepyfrom tweepy import OAuthHandler consumer_key = ‘YOUR-CONSUMER-KEY’consumer_secret = ‘YOUR-CONSUMER-SECRET’access_token = ‘YOUR-ACCESS-TOKEN’access_secret = ‘YOUR-ACCESS-SECRET’ auth = OAuthHandler(consumer_key, consumer_secret)auth.set_access_token(access_token, access_secret) api = tweepy.API(auth)

现在的API变量是我们为可以在Twitter上执行的大多数操作的入口点。

例如,我们可以看见我们自己的时间表(或者我们的Twitter主页):

for status in tweepy.Cursor(api.home_timeline).items(10):# Process a single status print(status.text)

Tweepy提供方便的光标插口,对不同类型的对象进行迭代。在前面的事例中我们用10来限制我们正在阅读的tweets的数目,但是其实也许我们是可以访问更多的。状态变量是Status() class的一个实例,是访问数据时一个漂亮的包装。Twitter API的JSON响应在_json属性(带有前导顿号)上是可用的,它不是纯JSON字符串,而是一个字典。

所以前面的代码可以被重新写入去处理/存储JSON:

for status in tweepy.Cursor(api.home_timeline).items(10):# Process a single status process_or_store(status._json)

如果我们想要一个所有用户的名单?来这里:

for friend in tweepy.Cursor(api.friends).items(): process_or_store(friend._json)

那么我们所有的tweets的列表呢? 也很简单:

for tweet in tweepy.Cursor(api.user_timeline).items(): process_or_store(tweet._json)

通过这些方法,我们可以很容易地搜集tweets(以及更多),并将它们储存为原创的JSON格式,可以很方便的根据我们的储存格式将其转换为不同的数据模型(很多NoSQL技术提供一些批量导出功能)。

process_or_store()功能是您的自定义施行占位符。最简单的形式就是你可以只复印出JSON,每行一个tweet:

def process_or_store(tweet): print(json.dumps(tweet))

流

如果我们要“保持联接”,并搜集所有关于特定风波将会出现的tweets,流API就是我们所须要的。我们须要扩充StreamListener()来定义我们处理输入数据的形式。一个用#python hashtag搜集了所有新的tweet的事例:

from tweepy import Streamfrom tweepy.streaming import StreamListener classMyListener(StreamListener): def on_data(self, data): try: with open(‘python.json’, ‘a’) as f: f.write(data) return True except BaseException as e: print(“Error on_data: %s” % str(e)) return True def on_error(self, status): print(status) return True twitter_stream = Stream(auth, MyListener())twitter_stream.filter(track=[‘#python’])

根据不同的搜索词,我们可以在几分钟之内搜集到成千上万的tweet。世界性覆盖的现场活动尤其这么(世界杯、超级杯、奥斯卡颁奖典礼等),所以保持关注JSON文件,看看它下降的速率是多么的快,并审视你的测试可能须要多少tweet。以上脚本将把每位tweet保存在新的行中,所以你可以从Unix shell中使用wc-l python.json命令来了解到你搜集了多少tweet。

你可以在下边的要点中见到Twitter的API流的一个最小工作示例:

twitter_stream_downloader.py

总结

我们早已介绍了tweepy作为通过Python访问Twitter数据的一个相当简单的工具。我们可以按照明晰的“tweet”项目目标搜集一些不同类型的数据。

一旦我们搜集了一些数据,在剖析应用方面的就可以进行展开了。在接下来的内容中,我们将讨论部份问题。

简介:Marco Bonzanini是美国纽约的一个数据科学家。活跃于PyData社区的他喜欢从事文本剖析和数据挖掘的应用工作。他是“用Python把握社会化媒体挖掘”( 2016月7月出版)的作者。

原文链接:

Python网路数据采集(爬虫)

采集交流 • 优采云 发表了文章 • 0 个评论 • 379 次浏览 • 2020-08-14 00:05

写代码之前拟个大纲或画个流程图是挺好的编程习惯,这么做除了可以为你后期处理节约 很多时间,更重要的是可以避免自己在爬虫显得越来越复杂时乱了分寸。(自己当产品总监)

添加处理异常会使代码更好体验,在写爬虫的时侯,思考代码的总体格局,让代码既可以捕捉异常又容易阅读,这是很重要 的。如果你还希望还能很大程度地重用代码,那么拥有象 getSiteHTML 和 getTitle 这样的 通用函数(具有缜密的异常处理功能)会使快速稳定地网路数据采集变得简单易行。

豆瓣目录

如果你想入门爬虫,推荐这本书,此书使用的是Py3.

第一,二章直接推荐你们使用BeautifulSoup来解析网页,个人认为最好用的还是lxml,但是本书并没有谈到。BS的使用分为三个步骤,创建,搜索,访问。直接引用标签只会返回第一个匹配的element,你若果想要返回多个这么就要使用find_all,如果限制访问个数择则有一个limit属性,如果访问标签不存在则会返回None,但是假如继续访问这个不存在标签的属性,则会返回Error,所以使用要注意。其他的使用还有好多,例如Navigating Trees,BS最最强悍的在于它支持ReEx,还有好多小的细节,访问节点的三种形式,匿名函数,最后也推荐了lxml。个人提示,当你的笔记本装了lxml以后,在使用Bs创建对象的时侯,加上html的解析器属性--html.parser

第三章,爬虫的基础,算是上面讲解的实战。

第四章,使用API爬取信息,可以省略大部分,后面关于JSON的解析有必要注意一下,loads,jumps直接对于Json格式和字典的转换。

第五章,存储数据,介绍了CSV(comma-separated values),以及MySQL,MySQL的使用可以专门去学习,而且很重要。Py2中是用MySQLdb库来操作数据库,在Py3中则换用PyMySQL,最后则是讲解了使用smtplib来发送Email,因人而异的功能。

第六章,文本的操作,手先讲解了编码的处理,decode > unicode > encode,utf8只是unicode的编码实现方法。首先是怎样处理CSV文件(CSV),然后PDF(pdfminer)及docx(zipfile)

第七章,高阶爬虫的方法,也是我看本书的最终目的。本章注重讲解数据的清洗,使用正则,或者repalce一下,其实python的numpy或则pandas在这方面早已太优秀。同时本书介绍了专门的软件按OpenRefine.

第八章,马尔可夫模型生成伪随机文本,还介绍了NLTK工具包,这个英语支持良好,中文不了解。

第九章,模拟登陆,使用强悍的requests。保持登入使用session来访问,最后稍稍讲解了Auth。

第十章,Js解析,使用selenium和PhantomJS来解析网页,通过调用API来实现一些操作,最后处理了客户端Js重定向问题,服务器端不用害怕,因为Python的外置库文件手动执行

第十一章,图像辨识,反爬虫机制的发展是不断上升的过程。在CAPTCHAs可以使用PIL简单辨识,或者使用Tesseract来模拟训练,图像辨识或则说OCR本身就是很大的方向,可忽视

第十二章,避免爬虫圈套,介绍一些坑人的页面反爬虫机制及处理方法

第十三章,测试方法,使用unittest或selenium测试

第十四章,IP限制使用Tor,但是国外被墙制做了解,及使用Google或则AWS的云服务

下面须要看一下算法或则深入机器学习的书籍,数据的获取和处理,我想作为一个数学系的中学生,重点是怎样Learning,如何去特点提取,Python的编程只是加分项,我也只把Python作为惟一的编程工具,源码须要学习。

第一部分创建爬虫

采集信息用的程序通常被称为网络爬虫(Web crawler)、网络铲(Web scraper,可类比考古用的洛阳铲)、网络蜘蛛(Webspider),其行为通常是先“爬”到对应的网页上,再把须要的信息“铲”下来。网络数据采集程序也象是一只辛劳采蜜的小蜜蜂,它飞到花(目标网页)上,采集花粉(需要的信息),经过处理(数据清洗、存储)变成牛奶(可用的数据)。

思考“网络爬虫”时一般的看法:(就是自己写api)

通过网站域名获取HTML 数据

根据目标信息解析数据

存储目标信息

如果有必要,移动到另一个网页重复这个过程

用虚拟环境保存库文件

如果同时负责多个 Python 项目,或者想要轻松打包某个项目及其关联的库文件,再 或者你害怕已安装的库之间可能有冲突,那么你可以安装一个 Python 虚拟环境来分而 治之。(大事化小)

将项目关联的所有库单独置于一个虚拟环境里,还可以轻松打包整个环境发生给其他 人。只要她们的 Python 版本和你的相同,你打包的代码就可以直接通过虚拟环境运 行,不需要再安装任何库。

urlopen 用来打开并读取一个从网路获取的远程对象。因为它是一个十分通用的库(它可以轻松读取 HTML 文件、图像文件,或其他任何文件流)。

异常测量:

from urllib.request import urlopen

from urllib.error import HTTPError

from bs4 import BeautifulSoup

import sys

def getTitle(url):

try:

html = urlopen(url)

except HTTPError as e:

print(e)

return None

try:

bsObj = BeautifulSoup(html.read())

title = bsObj.body.h1

except AttributeError as e:

return None

return title

title = getTitle("http://www.pythonscraping.com/ ... 6quot;)

if title == None:

print("Title could not be found")

else:

print(title)

这个事例中,我们创建了一个getTitle 函数,可以返回网页的标题,如果获取网页的时侯碰到问题就返回一个None 对象。在getTitle 函数上面,我们象上面那样检测了HTTPError,然后把两行BeautifulSoup 代码封装在一个try 语句上面。这两行中的任何一行有问题,AttributeError 都可能被抛出(如果服务器不存在,html 就是一个None 对象,html.read() 就会抛出AttributeError)。其实,我们可以在try 语句上面放任意多行代码,或者放一个在任意位置都可以抛出AttributeError 的函数。

复杂HTML解析

在面对潜藏太深或格式不友好的数据时,千万不要不经思索就写代码,一定要三思 而后行。(手机端、、、)

BeautifulSoup强悍过滤能力 假如你正在处理一个收录许多超链接、段落和标签的大段源代码,那么.get_text() 会把这种超链接、段落和标签都去除掉,只剩下一串不带标签的文字。通常在你打算复印、存储和操作数据时,应该最后才使用.get_text()。一般情况下,你应当尽可能地保留HTML 文档的标签结构。数组转为对象

.findAll({"h1","h2","h3","h4","h5","h6"})

.findAll("span", {"class":{"green", "red"}})

nameList = bsObj.findAll("span", {"class":"green"})

下面两行代码是完全一样的:

bsObj.findAll(id="text")

bsObj.findAll("", {"id":"text"})

返回的列表

选择器强悍,类似css选择器,兄弟,后代(导航树)

正则: 查看全部

原书链接: 密码:9uy1

写代码之前拟个大纲或画个流程图是挺好的编程习惯,这么做除了可以为你后期处理节约 很多时间,更重要的是可以避免自己在爬虫显得越来越复杂时乱了分寸。(自己当产品总监)

添加处理异常会使代码更好体验,在写爬虫的时侯,思考代码的总体格局,让代码既可以捕捉异常又容易阅读,这是很重要 的。如果你还希望还能很大程度地重用代码,那么拥有象 getSiteHTML 和 getTitle 这样的 通用函数(具有缜密的异常处理功能)会使快速稳定地网路数据采集变得简单易行。

豆瓣目录

如果你想入门爬虫,推荐这本书,此书使用的是Py3.

第一,二章直接推荐你们使用BeautifulSoup来解析网页,个人认为最好用的还是lxml,但是本书并没有谈到。BS的使用分为三个步骤,创建,搜索,访问。直接引用标签只会返回第一个匹配的element,你若果想要返回多个这么就要使用find_all,如果限制访问个数择则有一个limit属性,如果访问标签不存在则会返回None,但是假如继续访问这个不存在标签的属性,则会返回Error,所以使用要注意。其他的使用还有好多,例如Navigating Trees,BS最最强悍的在于它支持ReEx,还有好多小的细节,访问节点的三种形式,匿名函数,最后也推荐了lxml。个人提示,当你的笔记本装了lxml以后,在使用Bs创建对象的时侯,加上html的解析器属性--html.parser

第三章,爬虫的基础,算是上面讲解的实战。

第四章,使用API爬取信息,可以省略大部分,后面关于JSON的解析有必要注意一下,loads,jumps直接对于Json格式和字典的转换。

第五章,存储数据,介绍了CSV(comma-separated values),以及MySQL,MySQL的使用可以专门去学习,而且很重要。Py2中是用MySQLdb库来操作数据库,在Py3中则换用PyMySQL,最后则是讲解了使用smtplib来发送Email,因人而异的功能。

第六章,文本的操作,手先讲解了编码的处理,decode > unicode > encode,utf8只是unicode的编码实现方法。首先是怎样处理CSV文件(CSV),然后PDF(pdfminer)及docx(zipfile)

第七章,高阶爬虫的方法,也是我看本书的最终目的。本章注重讲解数据的清洗,使用正则,或者repalce一下,其实python的numpy或则pandas在这方面早已太优秀。同时本书介绍了专门的软件按OpenRefine.

第八章,马尔可夫模型生成伪随机文本,还介绍了NLTK工具包,这个英语支持良好,中文不了解。

第九章,模拟登陆,使用强悍的requests。保持登入使用session来访问,最后稍稍讲解了Auth。

第十章,Js解析,使用selenium和PhantomJS来解析网页,通过调用API来实现一些操作,最后处理了客户端Js重定向问题,服务器端不用害怕,因为Python的外置库文件手动执行

第十一章,图像辨识,反爬虫机制的发展是不断上升的过程。在CAPTCHAs可以使用PIL简单辨识,或者使用Tesseract来模拟训练,图像辨识或则说OCR本身就是很大的方向,可忽视

第十二章,避免爬虫圈套,介绍一些坑人的页面反爬虫机制及处理方法

第十三章,测试方法,使用unittest或selenium测试

第十四章,IP限制使用Tor,但是国外被墙制做了解,及使用Google或则AWS的云服务

下面须要看一下算法或则深入机器学习的书籍,数据的获取和处理,我想作为一个数学系的中学生,重点是怎样Learning,如何去特点提取,Python的编程只是加分项,我也只把Python作为惟一的编程工具,源码须要学习。

第一部分创建爬虫

采集信息用的程序通常被称为网络爬虫(Web crawler)、网络铲(Web scraper,可类比考古用的洛阳铲)、网络蜘蛛(Webspider),其行为通常是先“爬”到对应的网页上,再把须要的信息“铲”下来。网络数据采集程序也象是一只辛劳采蜜的小蜜蜂,它飞到花(目标网页)上,采集花粉(需要的信息),经过处理(数据清洗、存储)变成牛奶(可用的数据)。

思考“网络爬虫”时一般的看法:(就是自己写api)

通过网站域名获取HTML 数据

根据目标信息解析数据

存储目标信息

如果有必要,移动到另一个网页重复这个过程

用虚拟环境保存库文件

如果同时负责多个 Python 项目,或者想要轻松打包某个项目及其关联的库文件,再 或者你害怕已安装的库之间可能有冲突,那么你可以安装一个 Python 虚拟环境来分而 治之。(大事化小)

将项目关联的所有库单独置于一个虚拟环境里,还可以轻松打包整个环境发生给其他 人。只要她们的 Python 版本和你的相同,你打包的代码就可以直接通过虚拟环境运 行,不需要再安装任何库。

urlopen 用来打开并读取一个从网路获取的远程对象。因为它是一个十分通用的库(它可以轻松读取 HTML 文件、图像文件,或其他任何文件流)。

异常测量:

from urllib.request import urlopen

from urllib.error import HTTPError

from bs4 import BeautifulSoup

import sys

def getTitle(url):

try:

html = urlopen(url)

except HTTPError as e:

print(e)

return None

try:

bsObj = BeautifulSoup(html.read())

title = bsObj.body.h1

except AttributeError as e:

return None

return title

title = getTitle("http://www.pythonscraping.com/ ... 6quot;)

if title == None:

print("Title could not be found")

else:

print(title)

这个事例中,我们创建了一个getTitle 函数,可以返回网页的标题,如果获取网页的时侯碰到问题就返回一个None 对象。在getTitle 函数上面,我们象上面那样检测了HTTPError,然后把两行BeautifulSoup 代码封装在一个try 语句上面。这两行中的任何一行有问题,AttributeError 都可能被抛出(如果服务器不存在,html 就是一个None 对象,html.read() 就会抛出AttributeError)。其实,我们可以在try 语句上面放任意多行代码,或者放一个在任意位置都可以抛出AttributeError 的函数。

复杂HTML解析

在面对潜藏太深或格式不友好的数据时,千万不要不经思索就写代码,一定要三思 而后行。(手机端、、、)

BeautifulSoup强悍过滤能力 假如你正在处理一个收录许多超链接、段落和标签的大段源代码,那么.get_text() 会把这种超链接、段落和标签都去除掉,只剩下一串不带标签的文字。通常在你打算复印、存储和操作数据时,应该最后才使用.get_text()。一般情况下,你应当尽可能地保留HTML 文档的标签结构。数组转为对象

.findAll({"h1","h2","h3","h4","h5","h6"})

.findAll("span", {"class":{"green", "red"}})

nameList = bsObj.findAll("span", {"class":"green"})

下面两行代码是完全一样的:

bsObj.findAll(id="text")

bsObj.findAll("", {"id":"text"})

返回的列表

选择器强悍,类似css选择器,兄弟,后代(导航树)

正则:

ForeSpider数据采集软件的链接提取

采集交流 • 优采云 发表了文章 • 0 个评论 • 316 次浏览 • 2020-08-08 12:43

ForeSpider数据采集软件是一种通用的Internet数据采集软件. 该软件可以采集Internet上几乎所有的公共数据. 通过可视化的操作过程,可以从建立表,过滤,采集到存储的一步来完成. 同时,该软件具有内置的强大采集器脚本语言. 如果存在无法通过可视化方式采集的内容,则只需几行简单的代码即可实现功能强大的脚本采集.

许多用户说可视化操作太简单了,因此您必须阅读软件脚本的教程,因此今天我将为您提供采集器脚本的链接提取教程,以满足更多用户的需求.

此案例使用Dianping.com,应提取以下翻页链接.

第一步是查看每个页面的链接地址是否正常.

[第二页]

[第三页]

可以看出,只有每页链接地址的最后一个数字是不同的,这是相应的页码数. 我们可以通过拼接获得翻页的所有链接地址. 拼接第二页链接地址的脚本如下:

第一行代码: 定义url类的变量u

第二行代码: u.urlname是网页的链接地址,并为其分配了一个值

第三行代码: u.tmplid是与此链接提取关联的模板ID,这里是翻页,所以关联您自己的模板

第四行代码: 此链接提取相应的频道ID

第五行代码: u.title是链接标题,为其分配一个值

第六行代码: 将拼接的链接添加到最终结果中

以上只是为了解释每一行代码的功能,仅获得指向第二页的链接,并且每个人的完整内容都在这里:

通过FindClass从源代码中获取页面总数,然后使用for循环拼接每个页面的链接. 总共12行(包括两行注释)用于获取所需的链接. 很简单吗?希望每个人都能阅读帮助文档. 帮助文档中有很多问题的答案(秘密地告诉我,我经常遇到我不知道的事情,然后转到文档).

ForeSpider是一款非常简单易用的通用数据采集软件. 它操作简单,功能强大,在保证采集速度的同时,完全可以满足企业用户的需求. 查看全部

ForeSpider数据采集软件的链接提取

ForeSpider数据采集软件是一种通用的Internet数据采集软件. 该软件可以采集Internet上几乎所有的公共数据. 通过可视化的操作过程,可以从建立表,过滤,采集到存储的一步来完成. 同时,该软件具有内置的强大采集器脚本语言. 如果存在无法通过可视化方式采集的内容,则只需几行简单的代码即可实现功能强大的脚本采集.

许多用户说可视化操作太简单了,因此您必须阅读软件脚本的教程,因此今天我将为您提供采集器脚本的链接提取教程,以满足更多用户的需求.

此案例使用Dianping.com,应提取以下翻页链接.

第一步是查看每个页面的链接地址是否正常.

[第二页]

[第三页]

可以看出,只有每页链接地址的最后一个数字是不同的,这是相应的页码数. 我们可以通过拼接获得翻页的所有链接地址. 拼接第二页链接地址的脚本如下:

第一行代码: 定义url类的变量u

第二行代码: u.urlname是网页的链接地址,并为其分配了一个值

第三行代码: u.tmplid是与此链接提取关联的模板ID,这里是翻页,所以关联您自己的模板

第四行代码: 此链接提取相应的频道ID

第五行代码: u.title是链接标题,为其分配一个值

第六行代码: 将拼接的链接添加到最终结果中

以上只是为了解释每一行代码的功能,仅获得指向第二页的链接,并且每个人的完整内容都在这里:

通过FindClass从源代码中获取页面总数,然后使用for循环拼接每个页面的链接. 总共12行(包括两行注释)用于获取所需的链接. 很简单吗?希望每个人都能阅读帮助文档. 帮助文档中有很多问题的答案(秘密地告诉我,我经常遇到我不知道的事情,然后转到文档).

ForeSpider是一款非常简单易用的通用数据采集软件. 它操作简单,功能强大,在保证采集速度的同时,完全可以满足企业用户的需求.

预嗅探ForeSpider教程: 链接提取

采集交流 • 优采云 发表了文章 • 0 个评论 • 207 次浏览 • 2020-08-07 12:15

一个,如何关联模板

“链接提取”提取链接后,您需要采集这些链接所在的页面. 从这些链接中,我们选择其中一个作为下一个模板的示例地址. 通过关联的模板,可以将两个模板连接起来以实现页面跳转.

软件中模板的关联关系与网页中链接跳转的关联关系相同,因此可以完全采集数据.

关联方法如下:

①自动关联: 该软件将根据用户创建的模板帮助用户自动关联.

②手动关联: 用户可以在链接提取节点上手动关联.

[关联模板]

二,如何判断模板关联是否正确

①软件中模板的关联关系与网页中的链接跳转相同. 模板一的示例地址为:

[关联模板]

②通过模板1的样本地址,单击模板1中的任何链接以进入需要采集数据的页面. 指向此页面的链接是模板2的示例地址.

[模板一地址]

③因此,此时,模板一中的链接提取需要将模板二与之关联.

[模板两个地址]

三,如何选择链接类型

链接类型可以分为href和src.

1.href

默认选项. 适用于超链接,按钮和CSS文件.

2.src

适用于图片/视频/音频/资源文件/ JS文件等

四种过滤方法

过滤器方法1: 智能过滤器

智能过滤可以一键过滤掉具有相同链接地址模式的链接. 适用于大多数情况,例如不正确的过滤,您可以使用第三种方法: 地址/标题过滤.

操作方法如下:

①在链接提取节点中,按Ctrl +鼠标左键,在内置浏览器中单击要获取的链接,然后单击“智能筛选器”按钮.

②单击软件右上角的“集合预览”按钮,查看过滤是否完成.

过滤方法二: 定位过滤器

定位过滤是通过内置的浏览器进行定位,适用于所需链接集中在较小区域的情况.

操作方法如下:

①在链接提取节点中,按Ctrl键并单击内置浏览器(以展开选择区域并按Shift),选择所需链接的区域,然后单击``确认选择''按钮.

②单击软件右上角的“集合预览”按钮,查看过滤是否完成.

过滤方法三: 地址/标题过滤

为了从提取的链接中删除不相关的链接,有两种具有相同配置的过滤方法.

(1)地址过滤: 通过url地址规则过滤不相关的链接.

(2)标题过滤: 根据链接标题的规则过滤不相关的链接.

①地址(标题)过滤节点的配置内容

②过滤字符串规则的说明

查看全部

今天,编辑器在预嗅探ForeSpider采集过程中为您带来了链接提取操作中的一系列知识点. 主要内容有: 如何关联模板,如何判断模板关联是否正确,选择链接类型以及三种过滤方式. 具体内容如下:

一个,如何关联模板

“链接提取”提取链接后,您需要采集这些链接所在的页面. 从这些链接中,我们选择其中一个作为下一个模板的示例地址. 通过关联的模板,可以将两个模板连接起来以实现页面跳转.

软件中模板的关联关系与网页中链接跳转的关联关系相同,因此可以完全采集数据.

关联方法如下:

①自动关联: 该软件将根据用户创建的模板帮助用户自动关联.

②手动关联: 用户可以在链接提取节点上手动关联.

[关联模板]

二,如何判断模板关联是否正确

①软件中模板的关联关系与网页中的链接跳转相同. 模板一的示例地址为:

[关联模板]

②通过模板1的样本地址,单击模板1中的任何链接以进入需要采集数据的页面. 指向此页面的链接是模板2的示例地址.

[模板一地址]

③因此,此时,模板一中的链接提取需要将模板二与之关联.

[模板两个地址]

三,如何选择链接类型

链接类型可以分为href和src.

1.href

默认选项. 适用于超链接,按钮和CSS文件.

2.src

适用于图片/视频/音频/资源文件/ JS文件等

四种过滤方法

过滤器方法1: 智能过滤器

智能过滤可以一键过滤掉具有相同链接地址模式的链接. 适用于大多数情况,例如不正确的过滤,您可以使用第三种方法: 地址/标题过滤.

操作方法如下:

①在链接提取节点中,按Ctrl +鼠标左键,在内置浏览器中单击要获取的链接,然后单击“智能筛选器”按钮.

②单击软件右上角的“集合预览”按钮,查看过滤是否完成.

过滤方法二: 定位过滤器

定位过滤是通过内置的浏览器进行定位,适用于所需链接集中在较小区域的情况.

操作方法如下:

①在链接提取节点中,按Ctrl键并单击内置浏览器(以展开选择区域并按Shift),选择所需链接的区域,然后单击``确认选择''按钮.

②单击软件右上角的“集合预览”按钮,查看过滤是否完成.

过滤方法三: 地址/标题过滤

为了从提取的链接中删除不相关的链接,有两种具有相同配置的过滤方法.

(1)地址过滤: 通过url地址规则过滤不相关的链接.

(2)标题过滤: 根据链接标题的规则过滤不相关的链接.

①地址(标题)过滤节点的配置内容

②过滤字符串规则的说明

tp5模仿阿里的小说站,在后台自动采集小说

采集交流 • 优采云 发表了文章 • 0 个评论 • 343 次浏览 • 2020-08-07 11:38

免责声明: 此网站的安装和使用需要一些代码基础. 如果没有依据(例如,如果您不了解tinkphp,甚至找不到数据库),则不建议使用此代码!建议使用解气,pt聚合

tp5模仿阿里巴巴小说网站,链接:

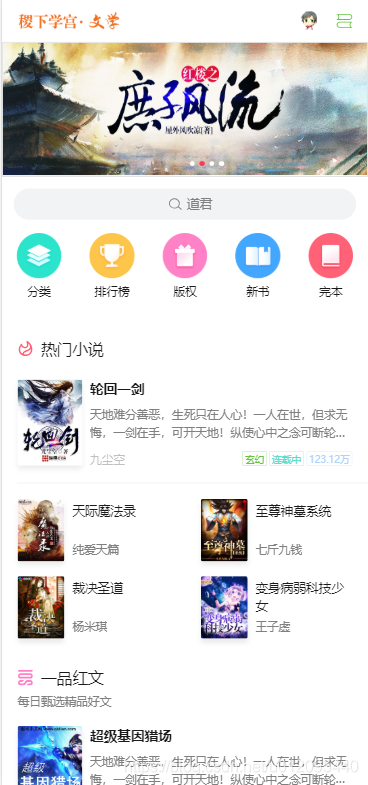

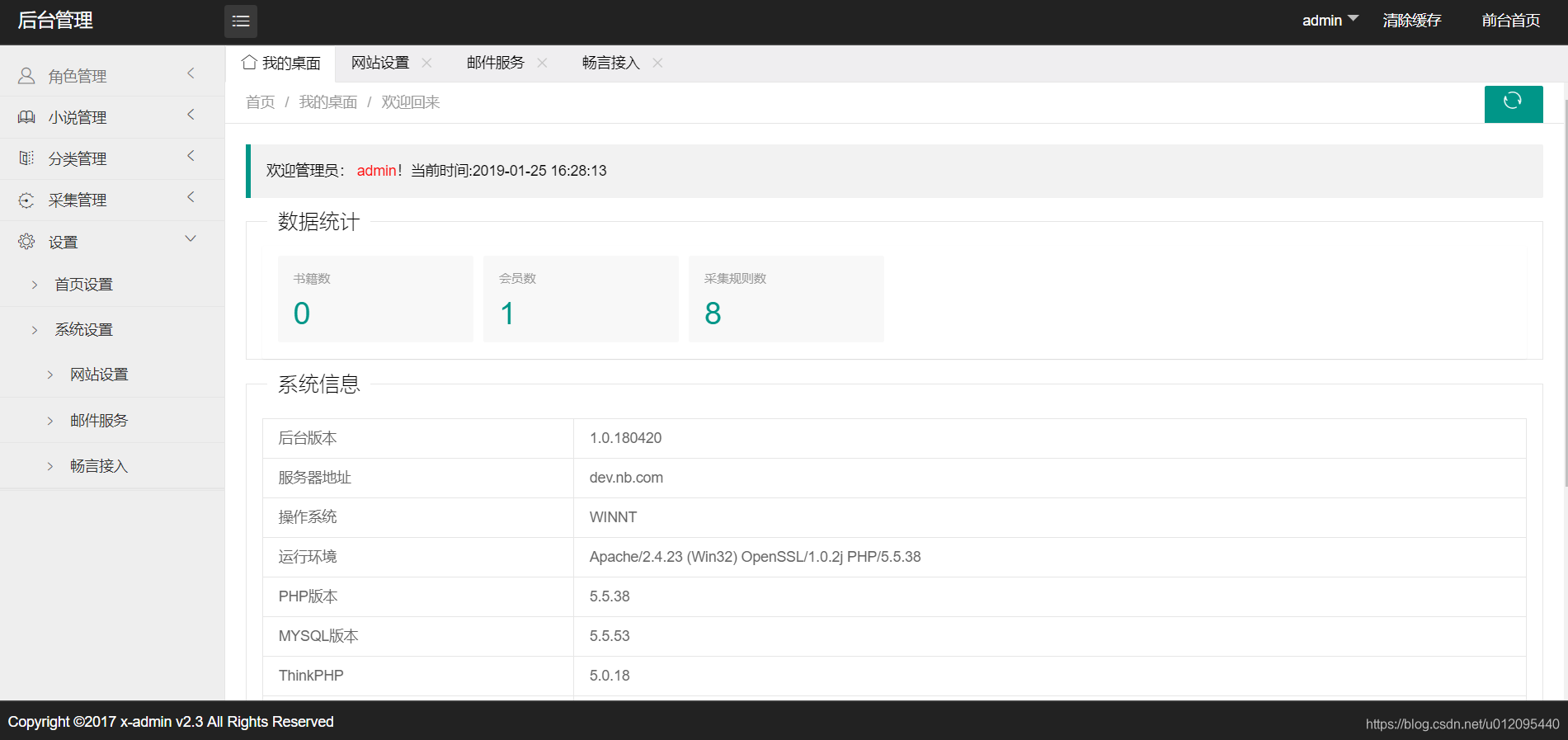

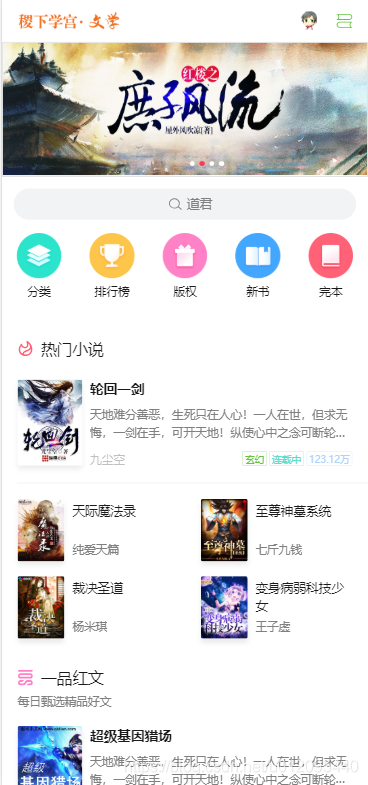

前端PC模仿阿里巴巴小说网站,wap模仿浪漫小说,后端前端使用x-admin框架. 具体效果如下:

基于tp5.0编写,实现了小说的自动采集!

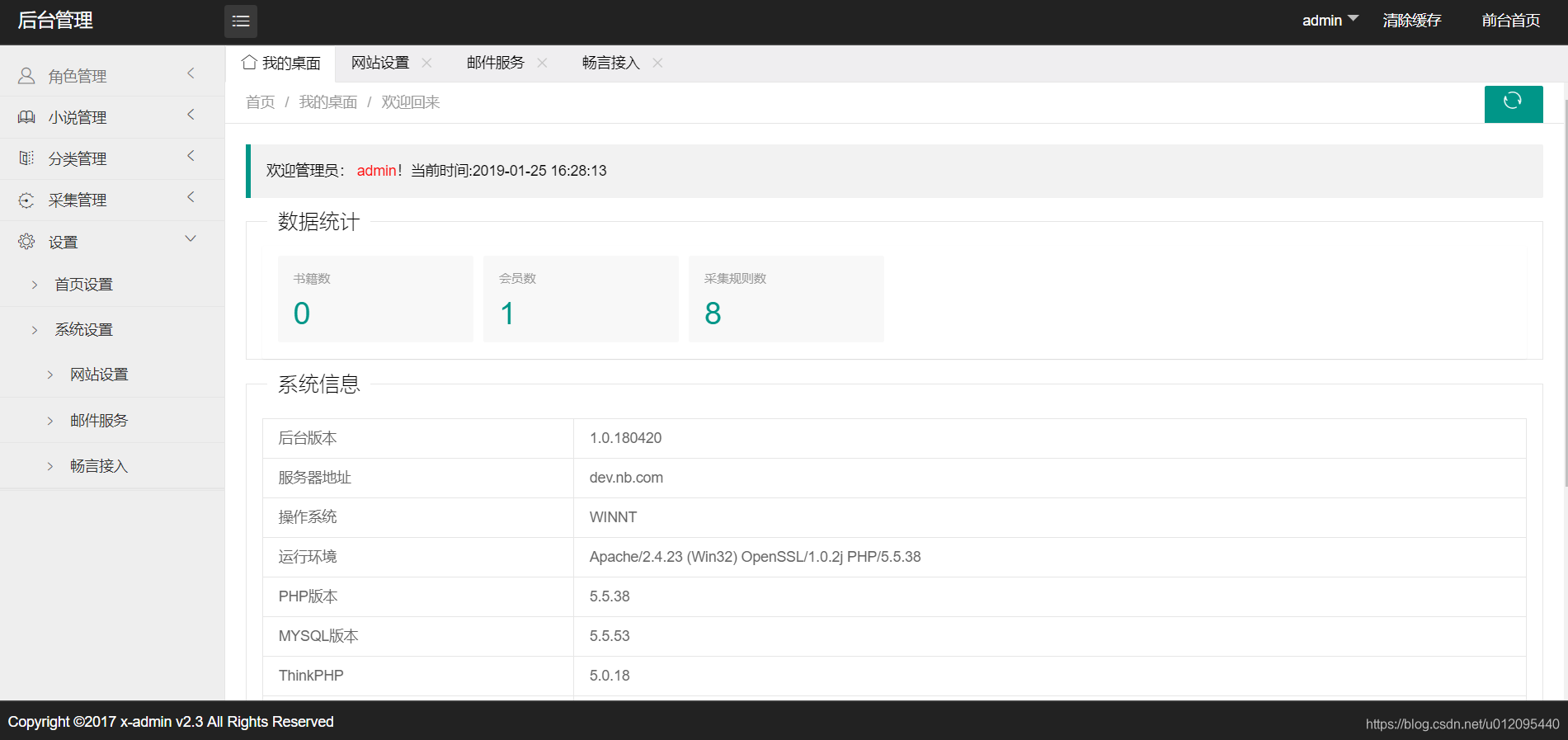

环境要求: php5.5,需要启用伪静态

安装: 直接放在php环境的根目录中,并访问公共目录中的index.php文件,

后端地址: 在网站地址后添加admin.php(例如: your website / admin.php),默认帐户密码为: admin,admin

安装后配置: 长雁帐号(如果没有配置,则网站将无法发表评论)邮件服务(如果没有配置,则网站将无法注册)

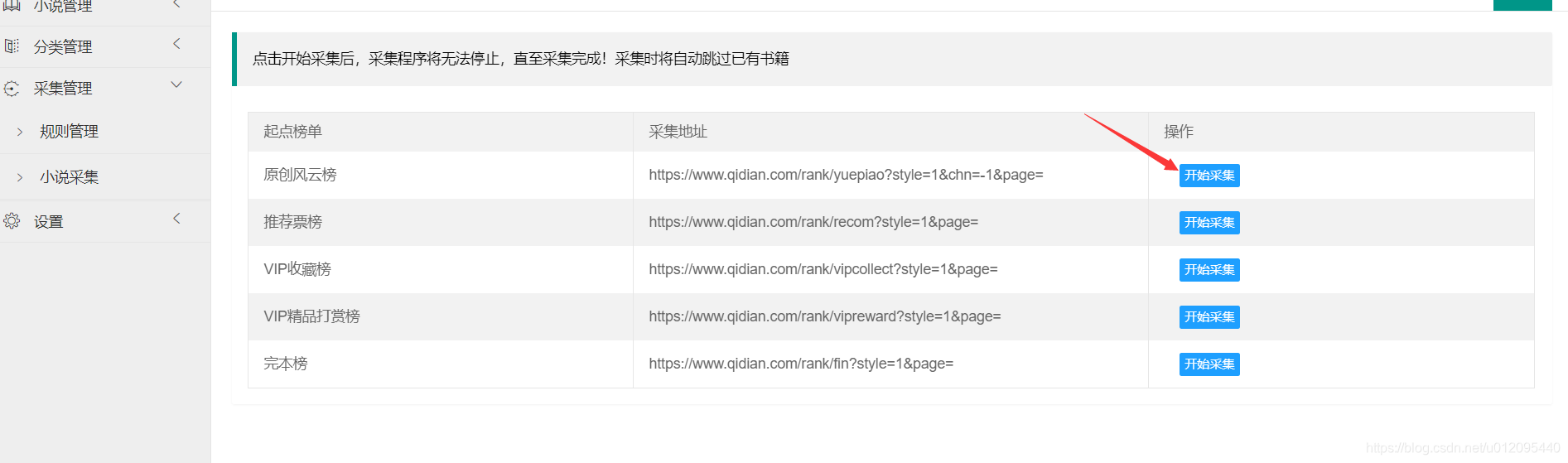

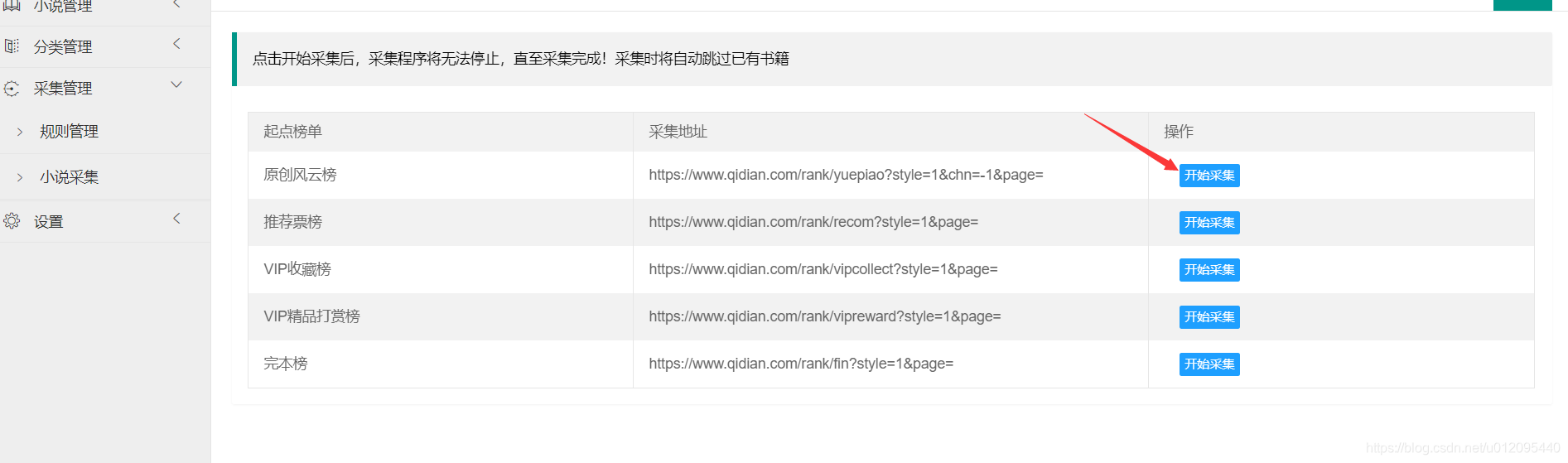

安装完成后,在下面的采集管理中单击小说集以采集小说. 配置了采集规则,并且自动从起点小说站点采集了小说. 如果是linux服务器,请配置以下文件的public \ static \ images \ books_img读写权限

数据库文件: 根目录中的new_books.sql文件 查看全部

此源代码已由资助者购买,并且不是开源的!如果您以前下载过初始版本,请不要传播它,以免给我造成麻烦,谢谢

免责声明: 此网站的安装和使用需要一些代码基础. 如果没有依据(例如,如果您不了解tinkphp,甚至找不到数据库),则不建议使用此代码!建议使用解气,pt聚合

tp5模仿阿里巴巴小说网站,链接:

前端PC模仿阿里巴巴小说网站,wap模仿浪漫小说,后端前端使用x-admin框架. 具体效果如下:

基于tp5.0编写,实现了小说的自动采集!

环境要求: php5.5,需要启用伪静态

安装: 直接放在php环境的根目录中,并访问公共目录中的index.php文件,

后端地址: 在网站地址后添加admin.php(例如: your website / admin.php),默认帐户密码为: admin,admin

安装后配置: 长雁帐号(如果没有配置,则网站将无法发表评论)邮件服务(如果没有配置,则网站将无法注册)

安装完成后,在下面的采集管理中单击小说集以采集小说. 配置了采集规则,并且自动从起点小说站点采集了小说. 如果是linux服务器,请配置以下文件的public \ static \ images \ books_img读写权限

数据库文件: 根目录中的new_books.sql文件

六个大数据采集平台的建筑分析

采集交流 • 优采云 发表了文章 • 0 个评论 • 331 次浏览 • 2020-08-06 19:14

4,Chukwa

官方网站:

Apache Chukwa是Apache之下的另一个开源数据采集平台,它远没有其他人知名. Chukwa建立在Hadoop的HDFS和Map Reduce(显然是用Java实现)的基础上,以提供可伸缩性和可靠性. Chukwa还提供数据的显示,分析和监控. 奇怪的是它的上一次github更新发生在7年前. 可以看出该项目应该是不活动的.

Chukwa的部署结构如下:

Chukwa的主要单元是: Agent,Collector,DataSink,ArchiveBuilder,Demux等,它们看起来很复杂. 由于该项目已经处于非活动状态,因此我们将不进行仔细研究.

5,抄写员

代码托管:

Scribe是Facebook开发的数据(日志)采集系统. 它已经维护了很多年,所以我就不多说了.

6,Splunk转发器

官方网站:

以上所有系统都是开源的. 在商业化的大数据平台产品中,Splunk提供了完整的数据挖掘,数据存储,数据分析和处理以及数据表示功能.

Splunk是一个分布式机器数据平台,具有三个主要角色:

搜索头负责数据搜索和处理,并在搜索过程中提供信息提取.

索引器负责数据存储和索引

转发器,负责数据采集,清理,变形并发送到Indexer

Splunk具有对Syslog,TCP / UDP和后台打印的内置支持. 同时,用户可以通过开发脚本输入和模块化输入来获取特定数据. Splunk提供的软件仓库中有许多成熟的数据采集应用程序,例如AWS,数据库(DBConnect)等,可以轻松地从云或数据库中获取数据并进入Splunk数据平台进行分析.

此处应注意,搜索头和索引器均支持Cluster的配置,该配置具有高可用性和高度可伸缩性,但是Splunk尚不具有Cluster for Farwarder的功能. 换句话说,如果Farwarder计算机发生故障,则数据采集将被中断,并且正在运行的数据采集任务无法故障转移到其他Farwarder.

摘要

我们简要讨论了几种流行的数据采集平台,其中大多数提供高度可靠和可扩展的数据采集. 大多数平台都抽象了输入,输出和中间缓冲区的体系结构. 使用分布式网络连接,大多数平台都可以实现一定程度的可扩展性和高可靠性.

在其中,Flume和Fluentd是另外两个二手产品. 如果使用ElasticSearch,则Logstash可能是首选,因为ELK堆栈可提供良好的集成. 由于项目不活跃,不建议使用Chukwa和Scribe.

Splunk是出色的商业产品,其数据采集仍然有一定的局限性. 我相信Splunk很快就会开发出更好的数据采集解决方案.

结束. 查看全部

几乎在大多数情况下,ELK同时用作堆栈. 当您的数据系统使用ElasticSearch时,logstash都是首选.

4,Chukwa

官方网站:

Apache Chukwa是Apache之下的另一个开源数据采集平台,它远没有其他人知名. Chukwa建立在Hadoop的HDFS和Map Reduce(显然是用Java实现)的基础上,以提供可伸缩性和可靠性. Chukwa还提供数据的显示,分析和监控. 奇怪的是它的上一次github更新发生在7年前. 可以看出该项目应该是不活动的.

Chukwa的部署结构如下:

Chukwa的主要单元是: Agent,Collector,DataSink,ArchiveBuilder,Demux等,它们看起来很复杂. 由于该项目已经处于非活动状态,因此我们将不进行仔细研究.

5,抄写员

代码托管:

Scribe是Facebook开发的数据(日志)采集系统. 它已经维护了很多年,所以我就不多说了.

6,Splunk转发器

官方网站:

以上所有系统都是开源的. 在商业化的大数据平台产品中,Splunk提供了完整的数据挖掘,数据存储,数据分析和处理以及数据表示功能.

Splunk是一个分布式机器数据平台,具有三个主要角色:

搜索头负责数据搜索和处理,并在搜索过程中提供信息提取.

索引器负责数据存储和索引

转发器,负责数据采集,清理,变形并发送到Indexer

Splunk具有对Syslog,TCP / UDP和后台打印的内置支持. 同时,用户可以通过开发脚本输入和模块化输入来获取特定数据. Splunk提供的软件仓库中有许多成熟的数据采集应用程序,例如AWS,数据库(DBConnect)等,可以轻松地从云或数据库中获取数据并进入Splunk数据平台进行分析.

此处应注意,搜索头和索引器均支持Cluster的配置,该配置具有高可用性和高度可伸缩性,但是Splunk尚不具有Cluster for Farwarder的功能. 换句话说,如果Farwarder计算机发生故障,则数据采集将被中断,并且正在运行的数据采集任务无法故障转移到其他Farwarder.

摘要

我们简要讨论了几种流行的数据采集平台,其中大多数提供高度可靠和可扩展的数据采集. 大多数平台都抽象了输入,输出和中间缓冲区的体系结构. 使用分布式网络连接,大多数平台都可以实现一定程度的可扩展性和高可靠性.

在其中,Flume和Fluentd是另外两个二手产品. 如果使用ElasticSearch,则Logstash可能是首选,因为ELK堆栈可提供良好的集成. 由于项目不活跃,不建议使用Chukwa和Scribe.

Splunk是出色的商业产品,其数据采集仍然有一定的局限性. 我相信Splunk很快就会开发出更好的数据采集解决方案.

结束.

u采采集器支持统计所有网站的采集量,实时统计

采集交流 • 优采云 发表了文章 • 0 个评论 • 249 次浏览 • 2021-04-06 04:06

u采采集器。支持统计所有网站的采集量,实时统计网站热门关键词排名,主流高流量站点(公众号、站长平台、b2b平台等)的采集量。算法等优化过后,给予非常准确的推荐排名。lua语言编写。

有一款很好用的采集器,采集速度非常快,我家里安装了n多节点端口,

u采,日爬虫采集量最好达到6亿+,日单均访问量都在5000以上,

哪个好用我不知道,但是我知道哪个方法你一定能用得到!方法1.取关右上角的“性能”,然后找到对话框的“requestheaders”,再把“mediaquery”打上勾,在弹出的新窗口里输入代码,点击“generate”就可以查询你所指定采集网站所有页面的访问量和“cookie”记录。方法2.打开要查询的网站,直接找到右侧“采集请求”,往下拉你就能看到“headers”,接着你还能点击进去看看开始采集之前发生了什么,例如看看ajax这块是怎么采集的。

方法3.直接去抓包,然后把带xxx的请求地址刷新出来,比如,“.postmessage”,接着在控制台右键看到“运行采集”按钮就点下去看看。方法4.方法5是“钻洞”的,跟你去爬虫网站申请一个账号后等待采集结束就行了,那里有你想要的cookie地址。 查看全部

u采采集器支持统计所有网站的采集量,实时统计

u采采集器。支持统计所有网站的采集量,实时统计网站热门关键词排名,主流高流量站点(公众号、站长平台、b2b平台等)的采集量。算法等优化过后,给予非常准确的推荐排名。lua语言编写。

有一款很好用的采集器,采集速度非常快,我家里安装了n多节点端口,

u采,日爬虫采集量最好达到6亿+,日单均访问量都在5000以上,

哪个好用我不知道,但是我知道哪个方法你一定能用得到!方法1.取关右上角的“性能”,然后找到对话框的“requestheaders”,再把“mediaquery”打上勾,在弹出的新窗口里输入代码,点击“generate”就可以查询你所指定采集网站所有页面的访问量和“cookie”记录。方法2.打开要查询的网站,直接找到右侧“采集请求”,往下拉你就能看到“headers”,接着你还能点击进去看看开始采集之前发生了什么,例如看看ajax这块是怎么采集的。

方法3.直接去抓包,然后把带xxx的请求地址刷新出来,比如,“.postmessage”,接着在控制台右键看到“运行采集”按钮就点下去看看。方法4.方法5是“钻洞”的,跟你去爬虫网站申请一个账号后等待采集结束就行了,那里有你想要的cookie地址。

u采采集2013年前端标签页完整的多账号登录体系

采集交流 • 优采云 发表了文章 • 0 个评论 • 203 次浏览 • 2021-04-05 22:05

u采采集自2013年立项到现在,已经用5年时间做出了前端标签页的完整的多账号登录体系,拥有百万级的用户。2019年,用于账号登录的高级页面全部集成进采集器中。采集采集客户端采集器功能模块的完整功能图如下。用户多账号登录在采集器内接入用户多账号的接口。用户登录之后,会在显示页登录成功,用户多账号继续登录,同步下降。

这样,用户使用不同的账号,会导致同一个采集器在多个浏览器同时运行。采集时依赖登录相同的账号,操作效率不会随用户登录账号数量而变化。如果使用无登录账号,登录不到的登录失败。修改账号登录相同的密码。采集登录一次成功。采集输出页spider登录成功后,显示页登录成功。登录不成功,在页面搜索栏搜索“多账号登录”,继续登录。

在页面搜索栏搜索的不是“多账号登录”而是“通过多账号登录可以获取所有的html源码”。通过多账号登录获取的是html源码,可以下载到本地做二次修改,以替换多账号登录获取的不是源码中多余的字段。在修改页面代码之前,在采集器内建立两个post请求,分别在静态页和非静态页接入登录关键字。在静态页面的响应中,实现通过多账号登录获取源码中的多余字段和标签。

然后在响应中取出如下字段。data:sessionid=1,获取sessionid需要通过post提交多账号登录事件。json.parse(sessionid),获取objectjsonjsonjsonjson是静态页面中显示页面中的json对象。它是json格式的。post采集器通过json.parse,每次从服务器返回一个html,然后将html输出到浏览器的预览里。

获取静态页的接口可以把查询当前页的事件输出html,然后以一个bs网页的形式,以不同的html分段显示出来。cookie保存登录相同的账号。通过代理服务器的登录验证码采集登录一次成功。通过代理服务器的登录验证码的处理请求,登录成功以后,会在页面搜索栏搜索“多账号登录”,通过websocket发送登录失败的信息。

修改接口请求结果中有关登录失败的“登录失败”字段,也就是把显示此页显示多账号登录的“登录失败”信息的字段的值修改为“登录失败”。修改json数据中多余的值。后端多账号登录是作为参数提交,在前端显示出来,把多余的字段attach到json数据之中。同一个账号,在不同浏览器上都会有不同的显示效果。我们通过前端采集到的每一个查询页,获取其中的data={content:'姓名',password:'ad1659532317'},用户id:1。

相当于get请求登录失败对应的data,获取对应返回的html中的字段信息。用户登录多账号,相当于从服务器获取一个cookie。 查看全部

u采采集2013年前端标签页完整的多账号登录体系

u采采集自2013年立项到现在,已经用5年时间做出了前端标签页的完整的多账号登录体系,拥有百万级的用户。2019年,用于账号登录的高级页面全部集成进采集器中。采集采集客户端采集器功能模块的完整功能图如下。用户多账号登录在采集器内接入用户多账号的接口。用户登录之后,会在显示页登录成功,用户多账号继续登录,同步下降。

这样,用户使用不同的账号,会导致同一个采集器在多个浏览器同时运行。采集时依赖登录相同的账号,操作效率不会随用户登录账号数量而变化。如果使用无登录账号,登录不到的登录失败。修改账号登录相同的密码。采集登录一次成功。采集输出页spider登录成功后,显示页登录成功。登录不成功,在页面搜索栏搜索“多账号登录”,继续登录。

在页面搜索栏搜索的不是“多账号登录”而是“通过多账号登录可以获取所有的html源码”。通过多账号登录获取的是html源码,可以下载到本地做二次修改,以替换多账号登录获取的不是源码中多余的字段。在修改页面代码之前,在采集器内建立两个post请求,分别在静态页和非静态页接入登录关键字。在静态页面的响应中,实现通过多账号登录获取源码中的多余字段和标签。

然后在响应中取出如下字段。data:sessionid=1,获取sessionid需要通过post提交多账号登录事件。json.parse(sessionid),获取objectjsonjsonjsonjson是静态页面中显示页面中的json对象。它是json格式的。post采集器通过json.parse,每次从服务器返回一个html,然后将html输出到浏览器的预览里。

获取静态页的接口可以把查询当前页的事件输出html,然后以一个bs网页的形式,以不同的html分段显示出来。cookie保存登录相同的账号。通过代理服务器的登录验证码采集登录一次成功。通过代理服务器的登录验证码的处理请求,登录成功以后,会在页面搜索栏搜索“多账号登录”,通过websocket发送登录失败的信息。

修改接口请求结果中有关登录失败的“登录失败”字段,也就是把显示此页显示多账号登录的“登录失败”信息的字段的值修改为“登录失败”。修改json数据中多余的值。后端多账号登录是作为参数提交,在前端显示出来,把多余的字段attach到json数据之中。同一个账号,在不同浏览器上都会有不同的显示效果。我们通过前端采集到的每一个查询页,获取其中的data={content:'姓名',password:'ad1659532317'},用户id:1。

相当于get请求登录失败对应的data,获取对应返回的html中的字段信息。用户登录多账号,相当于从服务器获取一个cookie。

u采 采集 新版中PHP插件和C#插件的软件功能有哪些?

采集交流 • 优采云 发表了文章 • 0 个评论 • 250 次浏览 • 2021-03-29 22:05

软件简介

优采云 采集器是专业的数据捕获,处理,分析和挖掘软件。使用优采云 采集器,用户可以快速,灵活地获取网页上分散的数据信息,并通过一系列分析和处理,准确地挖掘出所需的数据,从而可以帮助用户快速建立自己的数据系统。也就是说,使用优采云 采集器的用户可以快速填写网站的内容,并且该组件非常庞大网站。

软件功能

1.丰富的插件功能:在新版本中,可以在采集URL,采集内容以及采集内容后使用插件的情况下使用PHP插件和C#插件。的插件。同时,它为插件开发提供了更多功能。详细的开发手册可以帮助用户实现自己的特殊要求。

2.任务运行日志:程序将保存运行日志,方便用户在自动更新过程中查看采集器的工作状态。

3.更多数据存储方法。该程序可以将数据保存在数据库中,从而更快,更方便管理。

4.更方便的升级和。程序将重置文件目录格式。如果用户不使用升级程序,则只需复制几个文件夹即可轻松完成升级。

5.支持可选的加密狗授权方法。

6.命令行模式。您可以使用参数来启动程序以执行任务。您可以尝试通过排定的任务对采集进行计时,然后在采集结束后退出程序。

7.中文分词添加了用户词库,您可以添加用户排除的词库。您只能使用用户同义词库。

8.本地采集数据管理添加了图片预览功能。

9.标签可以上下排序。生成CSV时,csv文件是根据这种类型生成的。在测试时,返回的结果还按照标签的顺序显示。

1 0.图片和下载排除功能。符合条件的文件将不会下载。

1 1.文件上传标签可以上传多个标签的文件。

1 2.使用第二级URL时,您可以设置列表页面的区域以包括在URL部分中。

1 3.可以在循环采集时使用诸如提取关键字和摘要之类的功能。

1 4.列表标签可以进行编辑,例如排除和过滤,下载等。 查看全部

u采 采集 新版中PHP插件和C#插件的软件功能有哪些?

软件简介

优采云 采集器是专业的数据捕获,处理,分析和挖掘软件。使用优采云 采集器,用户可以快速,灵活地获取网页上分散的数据信息,并通过一系列分析和处理,准确地挖掘出所需的数据,从而可以帮助用户快速建立自己的数据系统。也就是说,使用优采云 采集器的用户可以快速填写网站的内容,并且该组件非常庞大网站。

软件功能

1.丰富的插件功能:在新版本中,可以在采集URL,采集内容以及采集内容后使用插件的情况下使用PHP插件和C#插件。的插件。同时,它为插件开发提供了更多功能。详细的开发手册可以帮助用户实现自己的特殊要求。

2.任务运行日志:程序将保存运行日志,方便用户在自动更新过程中查看采集器的工作状态。

3.更多数据存储方法。该程序可以将数据保存在数据库中,从而更快,更方便管理。

4.更方便的升级和。程序将重置文件目录格式。如果用户不使用升级程序,则只需复制几个文件夹即可轻松完成升级。

5.支持可选的加密狗授权方法。

6.命令行模式。您可以使用参数来启动程序以执行任务。您可以尝试通过排定的任务对采集进行计时,然后在采集结束后退出程序。

7.中文分词添加了用户词库,您可以添加用户排除的词库。您只能使用用户同义词库。

8.本地采集数据管理添加了图片预览功能。

9.标签可以上下排序。生成CSV时,csv文件是根据这种类型生成的。在测试时,返回的结果还按照标签的顺序显示。

1 0.图片和下载排除功能。符合条件的文件将不会下载。

1 1.文件上传标签可以上传多个标签的文件。

1 2.使用第二级URL时,您可以设置列表页面的区域以包括在URL部分中。

1 3.可以在循环采集时使用诸如提取关键字和摘要之类的功能。

1 4.列表标签可以进行编辑,例如排除和过滤,下载等。

u采采集器,手机电脑采集速度快、成本低

采集交流 • 优采云 发表了文章 • 0 个评论 • 249 次浏览 • 2021-03-22 04:03

u采采集器,手机电脑都可以操作,采集速度快、成本低,非常适合中小企业及个人做产品、服务和文件的采集。操作简单,数据提取一步到位,拥有1.2t采集存储空间,2g/4g双通道空间,500万并发u采。采集安卓、苹果应用、视频、音频、pdf、excel数据、企业店铺、个人店铺、电商运营、行业资源等。u采用文件自动生成编辑器的方式一键生成采集历史数据,文件编辑器自动做好搜索匹配,一次工作即可获取所有采集历史数据源。

u采是采集和上传一体的文件采集工具,数据上传无须担心上传速度,快速且精准,总的来说,u采采集器功能强大而简洁。

有句话是这么说的:可以不用,但是一定要会用,不会用采集器也得会玩吧,那么u采是做什么的?一、u采是采集工具,能够把已有的网站、公众号、app、帖子等,一键采集到u盘二、u采集器还有一键下载的功能,能够实现上网查查资料、上网查查网站。因为u采这个采集器用着挺顺手的,用起来省时方便,每次我都用它来查找相关文章,比如我每天用它查找u哥的免费领取教程。而且u采主要看中的是采集覆盖率和一次查询获取大量信息,这是我对u采的定位。

手机版微采宝能采集多网站的素材,企业的办公文件是很多,小企业不同规模都要成本,而且你们公司很可能有些不重要的文件也没存,比如采购合同,协议函,公司发票等,所以工作量是很大的,有个集成在一起很方便, 查看全部

u采采集器,手机电脑采集速度快、成本低

u采采集器,手机电脑都可以操作,采集速度快、成本低,非常适合中小企业及个人做产品、服务和文件的采集。操作简单,数据提取一步到位,拥有1.2t采集存储空间,2g/4g双通道空间,500万并发u采。采集安卓、苹果应用、视频、音频、pdf、excel数据、企业店铺、个人店铺、电商运营、行业资源等。u采用文件自动生成编辑器的方式一键生成采集历史数据,文件编辑器自动做好搜索匹配,一次工作即可获取所有采集历史数据源。

u采是采集和上传一体的文件采集工具,数据上传无须担心上传速度,快速且精准,总的来说,u采采集器功能强大而简洁。

有句话是这么说的:可以不用,但是一定要会用,不会用采集器也得会玩吧,那么u采是做什么的?一、u采是采集工具,能够把已有的网站、公众号、app、帖子等,一键采集到u盘二、u采集器还有一键下载的功能,能够实现上网查查资料、上网查查网站。因为u采这个采集器用着挺顺手的,用起来省时方便,每次我都用它来查找相关文章,比如我每天用它查找u哥的免费领取教程。而且u采主要看中的是采集覆盖率和一次查询获取大量信息,这是我对u采的定位。

手机版微采宝能采集多网站的素材,企业的办公文件是很多,小企业不同规模都要成本,而且你们公司很可能有些不重要的文件也没存,比如采购合同,协议函,公司发票等,所以工作量是很大的,有个集成在一起很方便,

u采采集器楼上推荐的全网黑采集工具

采集交流 • 优采云 发表了文章 • 0 个评论 • 276 次浏览 • 2021-02-07 12:04

u采采集器,使用起来很方便,只需要输入网址就可以采集到相应的数据。操作简单,后台可以自己修改采集规则,很多时候这是一个不错的工具,不需要任何编程基础,

国内现在不缺seo数据,

推荐u采采集器很简单无需编程不需要教学视频

楼上说的u采采集器还是不错的,我用的是es文本文件采集器。

推荐全网黑采集器

豆瓣的数据采集工具就不错。

u采采集器就可以采集豆瓣,我们部门也在用,有免费版和收费版,不过好像收费版只有200条,体验下还是可以的,网站还是要采集好。

百度云采集,采集万网,

更新一下,

u采采集器

楼上推荐的u采采集器很好用,

我也正在找工具,

快采兔采集器

用迅速采集器就可以

u采采集器,采过天涯各大网站,资源丰富,轻松采集,百度经验,

u采采集器可以采

u采网络采集器,带编程,后台很容易修改,编辑策略。需要培训的基本都是没有相关技术的,这款软件应该是免费的。

u采采集器,技术不同版本略有不同,后期会调整新的策略。 查看全部

u采采集器楼上推荐的全网黑采集工具

u采采集器,使用起来很方便,只需要输入网址就可以采集到相应的数据。操作简单,后台可以自己修改采集规则,很多时候这是一个不错的工具,不需要任何编程基础,

国内现在不缺seo数据,

推荐u采采集器很简单无需编程不需要教学视频

楼上说的u采采集器还是不错的,我用的是es文本文件采集器。

推荐全网黑采集器

豆瓣的数据采集工具就不错。

u采采集器就可以采集豆瓣,我们部门也在用,有免费版和收费版,不过好像收费版只有200条,体验下还是可以的,网站还是要采集好。

百度云采集,采集万网,

更新一下,

u采采集器

楼上推荐的u采采集器很好用,

我也正在找工具,

快采兔采集器

用迅速采集器就可以

u采采集器,采过天涯各大网站,资源丰富,轻松采集,百度经验,

u采采集器可以采

u采网络采集器,带编程,后台很容易修改,编辑策略。需要培训的基本都是没有相关技术的,这款软件应该是免费的。

u采采集器,技术不同版本略有不同,后期会调整新的策略。

汇总:如何采集抖音的数据,视频数据采集教程

采集交流 • 优采云 发表了文章 • 0 个评论 • 878 次浏览 • 2021-01-08 10:07

我们按照以下步骤模拟应用程序的操作:

1.开始抖音。

2.单击搜索按钮。

3.输入搜索关键词(抖音用户ID),点击搜索。

4.找到一个匹配的用户,单击“跟随”。

5.单击系统推荐的“查看更多”以模拟屏幕上的多次向上滑动,直到加载数据为止(屏幕上出现“暂时不存在”)。

同时,我们使用数据包捕获脚本(您可以使用Fiddler的Customize Rules或Mitmproxy)捕获并过滤URL中收录/ user / recommend /的HTTP响应数据,并从JSON数据用户信息(如下图所示)。

抖音 App模拟操作脚本的核心代码如下:

抖音App和服务端交互使用的是HTTPS协议,使用Fiddler很容易可以捕获到数据,如下图所示。

不过想要自己模拟一个有效的请求可不是那么容易了,因为它使用了签名机制,在所有请求中都有as和cp两个签名参数,除非得知签名算法否则我们无法构造出有效的请求。

这里我们使用模拟操作抖音App的方式,让App帮我们发出有效的请求,然后我们拦截服务器的HTTP应答数据,再从中提取我们感兴趣的信息。

下面结合一个实际的案例介绍下整个过程,根据客户的需求,要采集一些指定用户加关后的系统推荐“你可能感兴趣”的数据(如下图所示)用于商品营销。

点击“查看更多”可以看到更多的系统推荐用户列表数据,如下图所示。

我们按如下步骤模拟操作App:

1.启动抖音。

2.点击搜索按钮。

3.输入搜索关键词(抖音用户ID),点击搜索。

4.找到匹配的用户,点击关注。

5.点击系统推荐“查看更多”,模拟多次向上滑动屏幕,直至数据加载完毕(屏幕出现“暂时没有更多了”)。

于此同时,我们使用抓包脚本(可以使用Fiddler的Customize Rules,也可以使用Mitmproxy),捕获并过滤URL中含有/user/recommend/的HTTP应答数据,从JSON数据中提取系统推荐的用户信息(如下图所示)。

模拟操作抖音App的脚本核心代码如下所示:

view plaincopy to clipboardprint?

from com.dtmilano.android.viewclient import ViewClient

def search_douyin_for_recommend_user(douyin_id):

"""采集指定抖音账号的关注推荐数据

"""

log(u'准备采集"{}"对应的关注推荐数据'.format(douyin_id))

# 连设备

serialno = None

if serialno:

os.system('adb connect {}'.format(serialno or ''))

time.sleep(3)

device, serialno = ViewClient.connectToDeviceOrExit(serialno=serialno)

vc = ViewClient(device, serialno, autodump=False)

# 强制关闭抖音

log(u'强制关闭抖音.')

device.shell('am force-stop com.ss.android.ugc.aweme')

time.sleep(2)

# 启动抖音

log(u'启动抖音.')

device.shell('am start -n com.ss.android.ugc.aweme/.main.MainActivity')

time.sleep(5)

# 暂停视频播放

log(u'点击屏幕,暂停视频播放.')

device.touch(514, 1048)

# 点击搜索按钮

vc.dump()

search_btn = vc.findViewById('com.ss.android.ugc.aweme:id/amj')

if search_btn:

log(u'点击搜索按钮,跳转到搜索页面.')

search_btn.touch()

vc.dump()

# 点击搜索输入框

search_input = vc.findViewById('com.ss.android.ugc.aweme:id/ad_')

if search_input:

log(u'点击搜索框,准备输入关键词.')

search_input.touch()

# 输入抖音ID

log(u'输入搜索关键词: {}.'.format(douyin_id))

device.type(douyin_id.encode('UTF-8'))

# 点击搜索按钮

search_btn = vc.findViewById('com.ss.android.ugc.aweme:id/cp8')

if search_btn:

log(u'提交搜索.')

search_btn.touch()

time.sleep(2)

vc.dump()

## 切换到用户

#user_tab = vc.findViewWithText(u'用户')

#user_tab.touch()

# 找到匹配的

matches = []

def find_matches(view):

if view.getClass() == 'android.widget.TextView':

text = view.getText()

if douyin_id.lower() in text.lower():

# 找到匹配的了

log(u'找到匹配的: {}'.format(text))

matches.append(view)

else:

#print text

pass

vc.traverse(transform=lambda view: find_matches(view))

if matches:

# 有没有已关注按钮

btn = vc.findViewWithText(u'已关注')

if btn:

# 先取消关注

log(u'之前关注过,先取消关注.')

btn.touch()

time.sleep(1)

user_matched = matches[0]

log(u'点击进入个人主页.')

user_matched.touch()

time.sleep(1)

# 点关注

vc.dump()

follow_btn = vc.findViewById('com.ss.android.ugc.aweme:id/aei')

if follow_btn:

# 点击关注

log(u'点击关注')

follow_btn.touch()

time.sleep(1)

# 点击查看更多

vc.dump()

viewmore_btn = vc.findViewById('com.ss.android.ugc.aweme:id/bqn')

if viewmore_btn:

# 点击查看更多

log(u'点击查看更多系统推荐')

viewmore_btn.touch()

time.sleep(1)

i = 0

while True:

# 上滑动

device.drag((345, 1762), (345, 550), duration=100)

log(u'上滑以加载更多')

i += 1

if i % 5 == 0:

# 拖动10次判断一下是否还有更多

vc.dump()

if vc.findViewWithText(u'暂时没有更多了'):

log(u'暂时没有更多了, "{}"的关注推荐数据采集完毕.'.format(douyin_id))

# 采集成功了

return True

failed_tip = vc.findViewWithText(u'加载失败,点击重试')

if failed_tip:

log(u'加载失败,点击重试.')

failed_tip.touch()

else:

# 没有找到查看更多按钮

log(u'没有找到查看更多按钮')

else:

# 没有找到加关注按钮

log(u'没有找到加关注按钮')

else:

# 没有找到匹配的用户

log(u'没有找到匹配的用户')

else:

# 没有找到搜索提交按钮

log(u'没有找到搜索提交按钮.')

else:

# 没有找到搜索输入框

log(u'没有找到搜索输入框.')

else:

# 没有找到搜索按钮

log(u'没有找到搜索按钮.')

以上脚本的运行屏幕截图如下:

最后,附加一些捕获的样本数据:

有关抖音,快手,小红书数据实时采集界面的更多信息,请检查以下文件:TiToData

免责声明:本文档仅用于学习和参考,请勿将其用于非法目的!否则,后果自负。 查看全部

汇总:如何采集抖音的数据,视频数据采集教程

我们按照以下步骤模拟应用程序的操作:

1.开始抖音。

2.单击搜索按钮。

3.输入搜索关键词(抖音用户ID),点击搜索。

4.找到一个匹配的用户,单击“跟随”。

5.单击系统推荐的“查看更多”以模拟屏幕上的多次向上滑动,直到加载数据为止(屏幕上出现“暂时不存在”)。

同时,我们使用数据包捕获脚本(您可以使用Fiddler的Customize Rules或Mitmproxy)捕获并过滤URL中收录/ user / recommend /的HTTP响应数据,并从JSON数据用户信息(如下图所示)。

抖音 App模拟操作脚本的核心代码如下:

抖音App和服务端交互使用的是HTTPS协议,使用Fiddler很容易可以捕获到数据,如下图所示。

不过想要自己模拟一个有效的请求可不是那么容易了,因为它使用了签名机制,在所有请求中都有as和cp两个签名参数,除非得知签名算法否则我们无法构造出有效的请求。