python网页数据抓取

重点分析http服务器爬虫中的数据抓取部分技术分析

网站优化 • 优采云 发表了文章 • 0 个评论 • 131 次浏览 • 2022-09-08 20:15

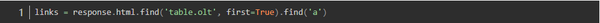

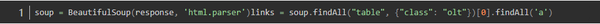

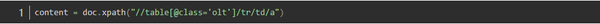

python网页数据抓取实践本文首发于"利兄"公众号。常见的数据抓取有网站抓取,http服务器抓取,爬虫三大类,其中前两种爬虫的特点是抓取速度快,用户体验好,实用性强,代码简单容易修改,且支持web服务环境,复用性高,可以让更多的人掌握并使用爬虫。爬虫的最终目的是获取数据,数据最终分为两大类:一是网页信息,二是数据相关信息,而网页信息如页面密码,页面定位都需要使用到数据提取,数据相关信息也需要被分析,如查看数据的不同类型,不同颜色的定位位置,不同的页面区域定位数据方法等。

为了更加了解爬虫的技术难点,本文重点分析http服务器爬虫中的数据抓取部分,涉及代码类型有:数据提取,正则匹配,正则解析,json解析,三种网页相关数据获取方法,获取数据思路等。http服务器抓取http服务器抓取是一种需要动态反爬虫技术的抓取模式,通过人工对服务器端反爬虫技术进行全面支持才能高效抓取网页信息,高效地进行正则表达式匹配和正则提取,快速从网页中提取数据,这里重点讲解http服务器抓取技术,如下:1.浏览器反爬虫攻击在一些小的网站上,会存在跨域或跨站点动态请求的问题,一些涉及到隐私的数据,往往没有交由服务端进行处理,爬虫就会获取到这些用户无意间发送的链接,通过这些静态网页发布者,爬虫就能够更加快速精准地去获取正在网页上的数据。

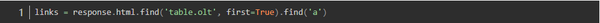

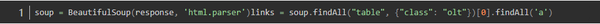

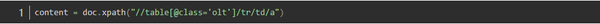

在浏览器上,浏览器都有一个反爬虫,beautifulsoup对于这些动态请求可以进行拦截,浏览器的反爬虫大致都是使用正则匹配+正则解析+正则匹配器组合方式,正则匹配比较简单,一般就是正则表达式相关的匹配方式,其中正则表达式只是一种标准正则的一种或几种形式,遇到想要的数据也可以使用特殊符号如逗号,双引号等对正则做些变动;正则提取也相对简单,需要正则相关库(如beautifulsoup、selenium等)支持;正则匹配是我们常常需要操作的数据类型,也可以说是javascript的一种api,适用于整个javascript历史之中,后面我们主要讲解正则匹配的使用2.正则表达式匹配捕获正则实际上就是一种对于字符的一种匹配(相对于一切字符,包括文本、各种算术运算符以及逻辑运算符等等),抓取一个javascript对象的时候,大多数情况需要一个像是正则表达式的字符串(其实每个正则对象都有正则表达式部分,根据正则对象的大小,运算引擎的实现等等),所以我们需要一个代码片段,这段代码片段至少有以下几个作用:1.浏览器不能识别通过正则表达式匹配的文本;2.javascript对象的所有属性必须匹配正则表达式;3.函。 查看全部

重点分析http服务器爬虫中的数据抓取部分技术分析

python网页数据抓取实践本文首发于"利兄"公众号。常见的数据抓取有网站抓取,http服务器抓取,爬虫三大类,其中前两种爬虫的特点是抓取速度快,用户体验好,实用性强,代码简单容易修改,且支持web服务环境,复用性高,可以让更多的人掌握并使用爬虫。爬虫的最终目的是获取数据,数据最终分为两大类:一是网页信息,二是数据相关信息,而网页信息如页面密码,页面定位都需要使用到数据提取,数据相关信息也需要被分析,如查看数据的不同类型,不同颜色的定位位置,不同的页面区域定位数据方法等。

为了更加了解爬虫的技术难点,本文重点分析http服务器爬虫中的数据抓取部分,涉及代码类型有:数据提取,正则匹配,正则解析,json解析,三种网页相关数据获取方法,获取数据思路等。http服务器抓取http服务器抓取是一种需要动态反爬虫技术的抓取模式,通过人工对服务器端反爬虫技术进行全面支持才能高效抓取网页信息,高效地进行正则表达式匹配和正则提取,快速从网页中提取数据,这里重点讲解http服务器抓取技术,如下:1.浏览器反爬虫攻击在一些小的网站上,会存在跨域或跨站点动态请求的问题,一些涉及到隐私的数据,往往没有交由服务端进行处理,爬虫就会获取到这些用户无意间发送的链接,通过这些静态网页发布者,爬虫就能够更加快速精准地去获取正在网页上的数据。

在浏览器上,浏览器都有一个反爬虫,beautifulsoup对于这些动态请求可以进行拦截,浏览器的反爬虫大致都是使用正则匹配+正则解析+正则匹配器组合方式,正则匹配比较简单,一般就是正则表达式相关的匹配方式,其中正则表达式只是一种标准正则的一种或几种形式,遇到想要的数据也可以使用特殊符号如逗号,双引号等对正则做些变动;正则提取也相对简单,需要正则相关库(如beautifulsoup、selenium等)支持;正则匹配是我们常常需要操作的数据类型,也可以说是javascript的一种api,适用于整个javascript历史之中,后面我们主要讲解正则匹配的使用2.正则表达式匹配捕获正则实际上就是一种对于字符的一种匹配(相对于一切字符,包括文本、各种算术运算符以及逻辑运算符等等),抓取一个javascript对象的时候,大多数情况需要一个像是正则表达式的字符串(其实每个正则对象都有正则表达式部分,根据正则对象的大小,运算引擎的实现等等),所以我们需要一个代码片段,这段代码片段至少有以下几个作用:1.浏览器不能识别通过正则表达式匹配的文本;2.javascript对象的所有属性必须匹配正则表达式;3.函。

python网页数据抓取库(gzip包加速)下载(图)

网站优化 • 优采云 发表了文章 • 0 个评论 • 144 次浏览 • 2022-09-06 02:02

python网页数据抓取库(gzip包加速)下载本文原发于公众号,有python爬虫基础的同学可以先看看公众号的文章一个网页里,到底有多少数据?这个网页中你可以看到5个在线答题页面,27个话题页面,122个问题列表页面,79个问题详情页面,168个问题评分页面,8个话题评论页面。一共有6389个问题。

(上图中数据类型都是python对象,在python中,python.html()返回html本身。python.document()返回python文档。)接下来,就是模拟一个淘宝商品销售页面这5个在线答题页面,27个话题页面,122个问题列表页面,79个问题详情页面,168个问题评分页面,8个话题评论页面。

<p>四种方法让你一秒获取数据首先,我们使用下面四种方法来下载数据(html):vv.urllib3.urllib3.requesthtml.xpath.parsefile.urlopen 查看全部

python网页数据抓取库(gzip包加速)下载(图)

python网页数据抓取库(gzip包加速)下载本文原发于公众号,有python爬虫基础的同学可以先看看公众号的文章一个网页里,到底有多少数据?这个网页中你可以看到5个在线答题页面,27个话题页面,122个问题列表页面,79个问题详情页面,168个问题评分页面,8个话题评论页面。一共有6389个问题。

(上图中数据类型都是python对象,在python中,python.html()返回html本身。python.document()返回python文档。)接下来,就是模拟一个淘宝商品销售页面这5个在线答题页面,27个话题页面,122个问题列表页面,79个问题详情页面,168个问题评分页面,8个话题评论页面。

<p>四种方法让你一秒获取数据首先,我们使用下面四种方法来下载数据(html):vv.urllib3.urllib3.requesthtml.xpath.parsefile.urlopen

像数据分析一样写 Web 页面,这个 Python 库做到了!

网站优化 • 优采云 发表了文章 • 0 个评论 • 132 次浏览 • 2022-07-15 18:02

插入文字

平时我们写 html 会用类似标签来控制标题,用

``这样的标签来输出文字。

在 PyWebIO 中可以使用 markdown 来实现类似效果,语法是put_markdown(),将markdown添加进去,就会自动渲染

put_markdown(("""# 我的第一个页面<br /><br /> 这是早起Python教我用Python写的第一个页面!<br /> <br /> 写点什么呢?到底写一点什么好呢?好像真的没什么好写的,到底写什么呢?<br /><br /> 我也不知道该写点什么, 反正有点什么内容就好了!"""), lstrip=True)<br />

效果如下

插入图片

静态元素是一个网页的重要组成部分,使用 PyWebIO 插入也是很简单,使用 put_image() 可以插入图片,代码如下

put_image(open('iShot2021-10-29 17.14.08.png', 'rb').read()) <br />

随手用手机拍了一张图片,效果如下

插入表格

传统html使用table插入表格,这里使用类似方法

put_table([<br /> ['商品', '价格'],<br /> ['苹果', '5.5'],<br /> ['香蕉', '7'],<br />])<br />

效果如下,后面如果表格内容需要变化,可以写个函数让他动态更新

插入代码

插入代码也是没有问题的

展示效果如下

交互 - 收集信息

上面都是常规的静态元素添加,其他一些库也能做到,甚至手写原生html都行,下面来点更高级的!

首先是简单的交互式输入框,开发者已经写好了,调用命令也很简单

name = input("你的名字是什么??")<br />

只用一行代码,效果如下,当然这也意味着样式什么的不支持修改

这里我们选择将接收到消息打印出来,当然也是可以写一个函数,将数据进行保存,这会在后面带大家开发问卷系统讲到

交互 - 隐藏输入

如果我们在开发问卷系统,有些选项希望用户输入时可以隐藏输入,就像输入密码一样

password = input("不想让别人看见你的输入?", type=PASSWORD)<br />

交互 - 输入代码

通过交互输入框接收代码也是可以的,后面我讲介绍如何让代码执行,下面是可以实现的样式

code = textarea('Code Edit', code={<br /> 'mode': "python", # code language<br /> 'theme': 'darcula', # Codemirror theme<br />}, value='import something\n# Write your python code')<br />

交互 - 按钮功能

其实上面说的存储数据也好,执行代码也好,本质上就是给这个提交按钮添加一个功能,我们来实现最简单的计算器。也就是点击提交,计算两数相加

data = input_group("做个计算器", [<br /> input('第一个数字', name='num1', type=NUMBER),<br /> input('第二个数字', name='num2', type=NUMBER)<br /> ])<br /> put_text(f"计算结果是{data['num1']} + {data['num2']} = {data['num1'] + data['num2']} ")<br />

因为简单,连函数都不用定义,直接 f-string 就解决了,如果需要复杂的功能,就可以定义一个函数,点击按钮就执行这个函数

如何渲染页面

从上面的介绍不难看出,用 PyWebIO 就好比往一张白纸里面塞东西。

但我还没说,如何创建一张白纸以及如何渲染页面,下面是一个本文用的最简单的框架

from pywebio import *<br />from pywebio.input import *<br />from pywebio.output import *<br /><br />def myfirstpage():<br /><br /> something<br /> <br />if __name__ == '__main__':<br /><br /> start_server(myfirstpage,port=8082,auto_open_webbrowser=True)<br />

可以看到,我们只要定义一个函数,然后往里面塞各种内容,最后通过start_server()指定端口启动就行!

03

小结

至此,有关 PyWebIO 开发页面的基本流程与常见操作就介绍完了。

是不是就像数据分析一样,拿着各种函数对数据一通操作,我们也是拿着各种写好的功能,需要一个添加一个! 如果你感兴趣的话,我强烈建议你自己敲一遍代码感受一下。

当然,本文介绍的代码只是最简单的demo,关于这个库我还有很多想说的,最近我用这个库亲自做了一个数据查询页面,如果你喜欢的话,可以给本文点赞支持一下!

各位伙伴们好,詹帅本帅搭建了一个个人博客和小程序,汇集各种干货和资源,也方便大家阅读,感兴趣的小伙伴请移步小程序体验一下哦!(欢迎提建议) 查看全部

像数据分析一样写 Web 页面,这个 Python 库做到了!

插入文字

平时我们写 html 会用类似标签来控制标题,用

``这样的标签来输出文字。

在 PyWebIO 中可以使用 markdown 来实现类似效果,语法是put_markdown(),将markdown添加进去,就会自动渲染

put_markdown(("""# 我的第一个页面<br /><br /> 这是早起Python教我用Python写的第一个页面!<br /> <br /> 写点什么呢?到底写一点什么好呢?好像真的没什么好写的,到底写什么呢?<br /><br /> 我也不知道该写点什么, 反正有点什么内容就好了!"""), lstrip=True)<br />

效果如下

插入图片

静态元素是一个网页的重要组成部分,使用 PyWebIO 插入也是很简单,使用 put_image() 可以插入图片,代码如下

put_image(open('iShot2021-10-29 17.14.08.png', 'rb').read()) <br />

随手用手机拍了一张图片,效果如下

插入表格

传统html使用table插入表格,这里使用类似方法

put_table([<br /> ['商品', '价格'],<br /> ['苹果', '5.5'],<br /> ['香蕉', '7'],<br />])<br />

效果如下,后面如果表格内容需要变化,可以写个函数让他动态更新

插入代码

插入代码也是没有问题的

展示效果如下

交互 - 收集信息

上面都是常规的静态元素添加,其他一些库也能做到,甚至手写原生html都行,下面来点更高级的!

首先是简单的交互式输入框,开发者已经写好了,调用命令也很简单

name = input("你的名字是什么??")<br />

只用一行代码,效果如下,当然这也意味着样式什么的不支持修改

这里我们选择将接收到消息打印出来,当然也是可以写一个函数,将数据进行保存,这会在后面带大家开发问卷系统讲到

交互 - 隐藏输入

如果我们在开发问卷系统,有些选项希望用户输入时可以隐藏输入,就像输入密码一样

password = input("不想让别人看见你的输入?", type=PASSWORD)<br />

交互 - 输入代码

通过交互输入框接收代码也是可以的,后面我讲介绍如何让代码执行,下面是可以实现的样式

code = textarea('Code Edit', code={<br /> 'mode': "python", # code language<br /> 'theme': 'darcula', # Codemirror theme<br />}, value='import something\n# Write your python code')<br />

交互 - 按钮功能

其实上面说的存储数据也好,执行代码也好,本质上就是给这个提交按钮添加一个功能,我们来实现最简单的计算器。也就是点击提交,计算两数相加

data = input_group("做个计算器", [<br /> input('第一个数字', name='num1', type=NUMBER),<br /> input('第二个数字', name='num2', type=NUMBER)<br /> ])<br /> put_text(f"计算结果是{data['num1']} + {data['num2']} = {data['num1'] + data['num2']} ")<br />

因为简单,连函数都不用定义,直接 f-string 就解决了,如果需要复杂的功能,就可以定义一个函数,点击按钮就执行这个函数

如何渲染页面

从上面的介绍不难看出,用 PyWebIO 就好比往一张白纸里面塞东西。

但我还没说,如何创建一张白纸以及如何渲染页面,下面是一个本文用的最简单的框架

from pywebio import *<br />from pywebio.input import *<br />from pywebio.output import *<br /><br />def myfirstpage():<br /><br /> something<br /> <br />if __name__ == '__main__':<br /><br /> start_server(myfirstpage,port=8082,auto_open_webbrowser=True)<br />

可以看到,我们只要定义一个函数,然后往里面塞各种内容,最后通过start_server()指定端口启动就行!

03

小结

至此,有关 PyWebIO 开发页面的基本流程与常见操作就介绍完了。

是不是就像数据分析一样,拿着各种函数对数据一通操作,我们也是拿着各种写好的功能,需要一个添加一个! 如果你感兴趣的话,我强烈建议你自己敲一遍代码感受一下。

当然,本文介绍的代码只是最简单的demo,关于这个库我还有很多想说的,最近我用这个库亲自做了一个数据查询页面,如果你喜欢的话,可以给本文点赞支持一下!

各位伙伴们好,詹帅本帅搭建了一个个人博客和小程序,汇集各种干货和资源,也方便大家阅读,感兴趣的小伙伴请移步小程序体验一下哦!(欢迎提建议)

python爬虫时需要用到一些小程序的如何用python爬取网上一些公司发布的招聘信息

网站优化 • 优采云 发表了文章 • 0 个评论 • 94 次浏览 • 2022-06-21 02:00

python网页数据抓取详细教程,分享学习方法!喜欢的老铁,点个关注呗小编今天给大家分享下关于python爬虫时需要用到一些小程序的如何用python爬取网上一些公司发布的招聘信息!网上发布的招聘信息确实很多,而且公司也很多,有的甚至是电话面试,有些是邮件联系,有些是暂时没有招聘,有些是请先网上了解下基本情况!下面我就分享下我分析总结出来的几种的简单实用的方法!(。

1)手动传送个人简历首先你得去网上找到想要的公司信息,然后上传简历至招聘网站,很简单,直接把公司信息复制,粘贴到浏览器的任意地方,然后点击下面的提交就行,可以多试几次,邮箱一般一天就会收到回复,但回复不一定是你想要的。如果你的简历是百度公司的,你也可以试一下直接用百度网盘分享,这样比传送多一些,点我提交的邮箱里面的链接,也可以出现该职位需要的简历内容,但是存在被删除的可能。

提交后的效果如下:一样的,提交后也要用文件提交,点下提交后可以存入手机,可以试一下,都是一样的,如果你的公司有一定规模的,而且需要招聘,传送简历的效果也不错,但这时候你需要一些小工具,比如雅虎日本的访问器,效果如下:一样,需要一些小工具,比如yahoo日本访问器等。你需要一些工具来帮你打开网站,这样你才可以直接加入面试,还需要一些小工具来加载html,比如swf文件,这时候你需要点击工具,选择对应的软件,目前绝大多数公司用的swf都是swfweb。最后发送简历的效果如下:网页右侧也需要有对应的代码。(。

2)刷新自己的网站这个我相信很多程序员都知道,也就是你需要把自己的网站清理下浏览器缓存,然后全屏模式打开别人写好的代码或者js,然后拖进去修改下文字,下面我提一下我用的是whatwg的框架jinja3,其实autolayout也是差不多的,jinja3以前是用这两个框架写,不过是自带的,现在jinja3则是集成了进来,这样我们就不需要自己写js和css了,自动生成,更加傻瓜方便。

这样我们在发送简历的时候在可以直接刷新,然后修改到自己想要的地方就可以了,或者直接可以保存在网页左上角的工具栏,效果如下:下面我用我写的简历内容框架来演示如何编写这个简历内容然后放到自己的网站上面,你可以使用最基本的语法来编写,比如:python+html+css+javascript。这样你就可以分析网站,然后自己写编写简历。举个栗子:这样你就很有趣的可以自己写简历内容,不用手动发送了。(。

3)打开企业网站如果这些公司并不提供简历数据接口,你可以去搜索网站, 查看全部

python爬虫时需要用到一些小程序的如何用python爬取网上一些公司发布的招聘信息

python网页数据抓取详细教程,分享学习方法!喜欢的老铁,点个关注呗小编今天给大家分享下关于python爬虫时需要用到一些小程序的如何用python爬取网上一些公司发布的招聘信息!网上发布的招聘信息确实很多,而且公司也很多,有的甚至是电话面试,有些是邮件联系,有些是暂时没有招聘,有些是请先网上了解下基本情况!下面我就分享下我分析总结出来的几种的简单实用的方法!(。

1)手动传送个人简历首先你得去网上找到想要的公司信息,然后上传简历至招聘网站,很简单,直接把公司信息复制,粘贴到浏览器的任意地方,然后点击下面的提交就行,可以多试几次,邮箱一般一天就会收到回复,但回复不一定是你想要的。如果你的简历是百度公司的,你也可以试一下直接用百度网盘分享,这样比传送多一些,点我提交的邮箱里面的链接,也可以出现该职位需要的简历内容,但是存在被删除的可能。

提交后的效果如下:一样的,提交后也要用文件提交,点下提交后可以存入手机,可以试一下,都是一样的,如果你的公司有一定规模的,而且需要招聘,传送简历的效果也不错,但这时候你需要一些小工具,比如雅虎日本的访问器,效果如下:一样,需要一些小工具,比如yahoo日本访问器等。你需要一些工具来帮你打开网站,这样你才可以直接加入面试,还需要一些小工具来加载html,比如swf文件,这时候你需要点击工具,选择对应的软件,目前绝大多数公司用的swf都是swfweb。最后发送简历的效果如下:网页右侧也需要有对应的代码。(。

2)刷新自己的网站这个我相信很多程序员都知道,也就是你需要把自己的网站清理下浏览器缓存,然后全屏模式打开别人写好的代码或者js,然后拖进去修改下文字,下面我提一下我用的是whatwg的框架jinja3,其实autolayout也是差不多的,jinja3以前是用这两个框架写,不过是自带的,现在jinja3则是集成了进来,这样我们就不需要自己写js和css了,自动生成,更加傻瓜方便。

这样我们在发送简历的时候在可以直接刷新,然后修改到自己想要的地方就可以了,或者直接可以保存在网页左上角的工具栏,效果如下:下面我用我写的简历内容框架来演示如何编写这个简历内容然后放到自己的网站上面,你可以使用最基本的语法来编写,比如:python+html+css+javascript。这样你就可以分析网站,然后自己写编写简历。举个栗子:这样你就很有趣的可以自己写简历内容,不用手动发送了。(。

3)打开企业网站如果这些公司并不提供简历数据接口,你可以去搜索网站,

Python数据抓取与可视化实战——网易云课堂人工智能与大数据板块课程实战

网站优化 • 优采云 发表了文章 • 0 个评论 • 117 次浏览 • 2022-06-18 19:53

本篇内容数据抓取对象为网易云课堂人工智能与大数据板块课程信息,使用的工具是urllib+postman,因为直接构建的POST抓取的josn数据包,所以数据抓取的代码非常简单,没有繁杂的xpath或者css表达式。可视化部分使用matplotlib,感谢刘顺祥大神的matplotlib教程系列,让我没怎么费力气就直接复用了大量代码!

以下是数据抓取部分代码:

import json,time<br />from urllib.request import urlopen,Request

headers = {<br /> 'content-type':'application/json',<br /> ###这里要特别注意,edu-script-token参数是一个变动从参数,<br /> ###每请求一次都会变动,所以这里的代码需要你使用自己在网易云课堂后台找到<br /> ###请求的edu-script-token参数,否则直接运行此代码是无法出结果的<br /> 'edu-script-token':'efb08e512fdc4c5e92346f2aed124144',

'Host':'study.163.com',<br /> 'Origin':'http://study.163.com',<br /> 'User-Agent':'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/61.0.3163.79 Safari/537.36'

}

Payloads={<br /> "pageIndex":1,<br /> "pageSize":50,<br /> "relativeOffset":0,<br /> "frontCategoryId":"400000000158033", <br /> "searchTimeType":-1,<br /> "orderType":0,<br /> "priceType":-1,<br /> "activityId":0

}

url='http://study.163.com/p/search/studycourse.json'<br />def GetCourses(url,header=headers,Payload=Payloads):

fullinfo=[]<br /> for i in range(1,17):

Payload['pageIndex']=i

Payload['relativeOffset']=50*i-50

content=Request(url,data=json.dumps(Payload).encode(encoding='utf-8'),headers=header)

response=json.loads(urlopen(content).read().decode('UTF-8'))

fullinfo=fullinfo+response['result']['list']

print("第{}页已抓取完毕".format(i))

time.sleep(1)

print("all page is OK!!!")<br /> return fullinfo<br />#运行程序:<br />mydata=GetCourses(url)<br />#转换为数据框<br />myresult=pd.DataFrame(mydata)<br />#查看变量信息:<br />myresult.info()

myresult=myresult.astype({'courseId':'str'})<br />#删除数据缺失列<br />nouse=['bigImgUrl','activityIds','gmtModified','published','schoolShortName','tagIap','tagLectorTime','courseCardProps','displayType','endTime','imgUrl','productId','startTime']

myresult=myresult.drop(nouse, axis=1)

myresult.head(10) <br />#预览数据<br />myresult=myresult.set_index('courseId')<br />myresult.to_csv('D:/Python/Data/yunketang_ai_bigdata.csv')

以下是使用Chome+postman进行POST请求构建的过程:

以上是本次爬取数据表,按照这些字段属性,之前曾经做过一期网易云课堂Excel模块课程抓取与可视化的推送。因为云课堂的课程信息字段基本一致,本次分析仍然 按照那个思路进行。

结合我个人的需求以及云课堂的课程评价体系,我将本次分析的目标及思路梳理如下:

课程来源分析课程内容分析课程价格分析课程知名度分析课程口碑分析

根据以上几个模块,我们开始今天的可视化分析之旅!

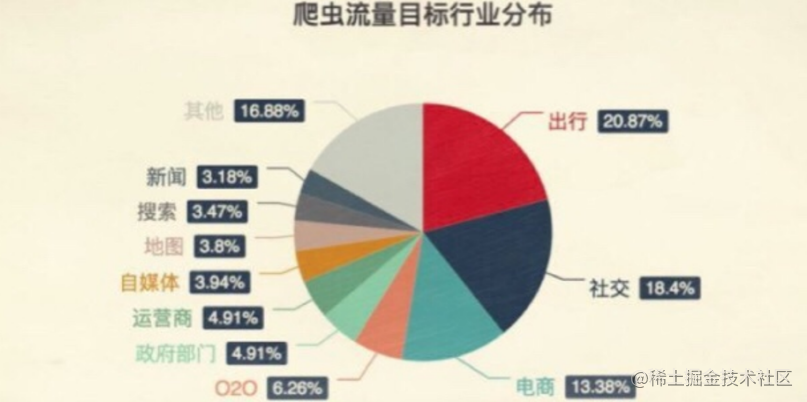

1、课程来源分析:

云课堂人工智能与大数据模块一共有791门有效课程,课程字段中提供了机构信息和教师信息,倘若机构信息与教师信息一致,那么基本可以认为课程是个人名义发布的,否则则是以机构名义发布的。(不一定客观,本次以代码练习为主)。

myresult.columns

sum(myresult.lectorName==myresult.provider)/len(myresult)<br />0.34639696586599239

import matplotlib.pyplot as plt

%matplotlib inline

plt.style.use('classic')

labels = ['个人','机构']

colors=['#2D6D66','#008BBC']

plt.figure(figsize=(8,6),facecolor='#ebebeb')

plt.rcParams['font.sans-serif'] = ['Microsoft YaHei']

plt.rcParams['axes.unicode_minus'] = False<br />plt.axes(aspect='equal',facecolor='#ebebeb')

ax =plt.gca()

ax.spines['left'].set_visible(False)

ax.spines['right'].set_visible(False)

ax.spines['top'].set_visible(False)

ax.spines['bottom'].set_visible(False)

plt.xlim(0,4)

plt.ylim(0,4)# 绘制饼图plt.pie(percent,

labels=labels,

colors=colors,

autopct='%.1f%%',

pctdistance=0.8,

labeldistance = 1.15,

startangle = 90,

radius = 1.5,

counterclock = False,

wedgeprops = {'linewidth': 0.5,'edgecolor':'white'},

textprops = {'fontsize':14,'color':'k'},

center = (1.8,1.8),

frame = 1 )

plt.xticks(())

plt.yticks(())

plt.title('云课堂人工智能与大数据模块课程来源性质分布',fontdict={'fontsize':16},loc='left')

plt.show()

从饼图可以很明显的看到,个人发布的课程占据整个课程模块课程总量的约35%,而机构则占了大多数,搞到65%,还记得我们上次分析Excel板块课程的时候得到的结论吗,Excel板块的课程中个人发布的课程量高达63%,而人工智能大数据板块则是机构的天下。个人觉得人工智能与大数据行业是一个高门槛、高技术行业,所需要的条件和依赖的资源都不是个人可以负担的,所以这个行业的课程基本都是机构或者团队化运作。

作者贡献数:

import squarify<br />import random

count=myresult['provider'].value_counts()

count=count.sort_values(ascending=False)

以下通过树状图来呈现那些发布课程频率(数量)比较处于前列的机构或者个人。

plt.style.use('classic')

plt.rcParams['font.sans-serif'] = 'Microsoft YaHei'plt.rcParams['axes.unicode_minus'] = Falseplt.figure(figsize=(13,10),facecolor='#ebebeb')

colors = ['#6794a7','#014d64','#76c0c1','#01a2d9','#7ad2f6','#00887d']

plot = squarify.plot(sizes =count[count>5].values ,

label = list(count[count>10].index)+['']*27,

color = random.choices(colors,k=len(count[count>5])),

alpha = 0.6,

value = list(count[count>10].values)+['']*27,

edgecolor = 'white',

linewidth =1

)

plot.set_title('云课堂人工智能与大数据课程发布来源统计',fontdict = {'fontsize':18},loc='left')

plt.axis('off')

plt.tick_params(top = 'off', right = 'off')

plt.show()

我筛选了发布课程的前十名,并用条形图来进行呈现。

plt.style.use('classic')

plt.rcParams['font.sans-serif'] =['Microsoft YaHei']

plt.rcParams['axes.unicode_minus'] = False<br />plt.figure(figsize=(10,6),facecolor='#ebebeb')

plt.barh(range(9,-1,-1),count.values[:10], align = 'center',color=random.choices(colors), alpha = 0.8)

plt.xlim(1,55)

plt.yticks(range(9,-1,-1),count.index[:10])

plt.xlabel('课程发布数')

plt.title('云课堂人工智能与大数据课程模块发布量TOP10统计',fontdict = {'fontsize':18},loc='left')

ax =plt.gca()

ax.spines['left'].set_visible(False)

ax.spines['right'].set_visible(False)

ax.spines['top'].set_visible(False)

ax.spines['bottom'].set_visible(False)

ax.grid(axis= 'x',which= 'major',linestyle='dashed',color='grey')<br /> for x,y in zip(range(9,-1,-1),count.values[:10]):

plt.text(y+0.2,x,'%s' %y,va='center')

plt.show()

通过以上树状图和条形图的数据呈现,我们可以很清晰的看到,小蚊子团队居然在人工智能和大数据板块一共发布了51门课程,要知道这个模块一共只有791门有效课程,这可是足足占了总课程量的51/791=6.5%啊我天,着实是高产至极,记得最初学习数据分析的时候,就层看过张闻霖老师的谁说菜鸟不会数据分析系列,为老师的高产点赞!!!

这个条形图可以看出发布课程数在10门以上的top10作者,基本呈现三级梯队分布,各梯队间距10门左右,小蚊子数据分析基本占据第一梯队,出于第二梯队的是普开数据柠檬学院和经管之家CDA数据分析研究院,分别发布了40、39门课程。而第三梯队课程发布数基本在30门以下,除了唐宇迪老师发布了26门,SAP中国渠道云学院发布了20门之外,其他均不足20门。鉴于人工智能与大数据行业的高门槛性,依然能以这么高频率发布课程,当然是只有团队运作才能支撑的起如此的资源和高强度课程量,这样印证了我们上文说过的,机构作者与个人作者的分布比例。

count2=myresult['provider'].value_counts()

plt.style.use('classic')

plt.rcParams['font.sans-serif'] = 'Microsoft YaHei'<br />plt.rcParams['axes.unicode_minus'] = False<br />fig = plt.figure(figsize=(10,6),facecolor='#ebebeb')

plt.plot(range(0,219),

count2.cumsum(),

linestyle = '-',

linewidth = 2,

color = '#2D6D66',

marker = 'o',

markersize = 4,

markeredgecolor='white',

markerfacecolor='#C10534'

)

plt.title('人工智能与大数据课程累计发布频率分布')

plt.xlabel('作者累计数(按照发布课程数量排序)')

plt.ylabel('课程发布频数')

ax =plt.gca()

ax.spines['left'].set_visible(False)

ax.spines['right'].set_visible(False)

ax.spines['top'].set_visible(False)

ax.spines['bottom'].set_visible(False)

ax.grid(axis= 'x',which= 'major',linestyle='dashed',color='grey')

plt.xlim(-1,225)

plt.yticks(range(0,800,100),range(0,800,100))

plt.tick_params(top = 'off',right='off')

plt.show()

以上我将所有课程作者按照发布课程频数做了累计分布呈现,可以看到前50个作者的课程贡献数已经累计达到了500门以上,而之后分布曲线已经大幅走缓,最后坡度已经接近直线,说明该板块的课程主要集中在那些少数机构手中,特别是前50名作者发布了超过500门课程,也即25%的作者掌握着70%以上的课程资源,可见该模块课程的垄断程度。

2、课程内容分析:

import jieba<br />from wordcloud <br />import WordCloud, STOPWORDS, ImageColorGenerator <br />import matplotlib.pyplot as plt<br />import numpy as np

课程标题分词高频词汇统计

word_list = [" ".join(jieba.cut(sentence)) for sentence in myresult['productName']]

new_text = ' '.join(word_list)

wc= WordCloud(

background_color="white",

max_words=2000,

stopwords=STOPWORDS.add("said"),

max_font_size=80,

font_path = 'msyh.ttf',

random_state=42

)

wordcloud =wc.generate(new_text)

fig = plt.figure(figsize=(10,8),facecolor='#ebebeb')

plt.imshow(wordcloud,interpolation="bilinear")

plt.axis("off")

plt.show()

课程描述高频词汇统计

word_list = [" ".join(jieba.cut(sentence)) for sentence in myresult['description'] if sentence!=None]

new_text = ' '.join(word_list)

new_text=new_text.replace("\n","")

wc= WordCloud(

background_color="white",

max_words=2000,

stopwords=STOPWORDS.add("said"),

max_font_size=80,

font_path = 'msyh.ttf',

random_state=42

)

wordcloud =wc.generate(new_text)

fig = plt.figure(figsize=(10,8),facecolor='#ebebeb')

plt.imshow(wordcloud,interpolation="bilinear")

plt.title('人工智能与大数据课程描述高频词统计')

plt.axis("off")

plt.show()

从课程名称以及课程描述的分词统计来看,该模块的标题还是侧重与基础、入门、实战、应用等较低层次的需要需求,而对于机器学习、深度学习、算法、构架等较为深入的层面词频分布较少,这也从侧面可以看出,网易云课堂的大数据与人工智能模块课程更侧重数据科学的入门、通识级别学习资源。(由于手头没有合适的关于数据科学领域的停止词,所以没有使用停止词,函数中那个停止词是英文的,只能清楚一些特殊符号和标点,所以课程描述的分词结果并不理想)。

3、课程价格分析

本来对于课程来讲,价格分析是极具价值的课程信息,但是遗憾的是,折扣价缺失过于严重,这里我用原价进行分析(尽管原始价格可能不能反映课程质量)。

price_data1=myresult.loc[myresult['originalPrice']!=0,['lectorName','originalPrice','productName','learnerCount','score']].sort_values(by='originalPrice',ascending=False)

len(price_data1)/len(myresult);len(price_data1)<br />0.6662452591656132527

从原始价格来看,一共有527门付费课程,总体付费课程占比66.7%。但是对于在线课程而言,单纯高价而没有用户(或者用户极少),或者完全为了给其他平台引流而免费,都不能真正体现出课程的价值。

price_data1.iloc[:10]

价格前十位的用户数可以看出,除了第二个课程外,这些价格虚高的课程很少有人问津,或者换句话说,网易云课堂本就不是一个人工智能与大数据深度课程资源集聚地,多数课程以入门或者通识为主,而学习者的对于高价课程的付费意愿也不高,这到底是因为云课堂的平台性质决定了内容深度,还是用户群体的需求性质与付费意愿决定了课程内容与深度,这一点很难讲。

我剔除掉10元以下、1000元以上的课程,希望这样可以使得结果相对客观一些!

<p>course1000=price_data1.loc[(price_data1.originalPrice>=10) &(price_data1.originalPrice 查看全部

Python数据抓取与可视化实战——网易云课堂人工智能与大数据板块课程实战

本篇内容数据抓取对象为网易云课堂人工智能与大数据板块课程信息,使用的工具是urllib+postman,因为直接构建的POST抓取的josn数据包,所以数据抓取的代码非常简单,没有繁杂的xpath或者css表达式。可视化部分使用matplotlib,感谢刘顺祥大神的matplotlib教程系列,让我没怎么费力气就直接复用了大量代码!

以下是数据抓取部分代码:

import json,time<br />from urllib.request import urlopen,Request

headers = {<br /> 'content-type':'application/json',<br /> ###这里要特别注意,edu-script-token参数是一个变动从参数,<br /> ###每请求一次都会变动,所以这里的代码需要你使用自己在网易云课堂后台找到<br /> ###请求的edu-script-token参数,否则直接运行此代码是无法出结果的<br /> 'edu-script-token':'efb08e512fdc4c5e92346f2aed124144',

'Host':'study.163.com',<br /> 'Origin':'http://study.163.com',<br /> 'User-Agent':'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/61.0.3163.79 Safari/537.36'

}

Payloads={<br /> "pageIndex":1,<br /> "pageSize":50,<br /> "relativeOffset":0,<br /> "frontCategoryId":"400000000158033", <br /> "searchTimeType":-1,<br /> "orderType":0,<br /> "priceType":-1,<br /> "activityId":0

}

url='http://study.163.com/p/search/studycourse.json'<br />def GetCourses(url,header=headers,Payload=Payloads):

fullinfo=[]<br /> for i in range(1,17):

Payload['pageIndex']=i

Payload['relativeOffset']=50*i-50

content=Request(url,data=json.dumps(Payload).encode(encoding='utf-8'),headers=header)

response=json.loads(urlopen(content).read().decode('UTF-8'))

fullinfo=fullinfo+response['result']['list']

print("第{}页已抓取完毕".format(i))

time.sleep(1)

print("all page is OK!!!")<br /> return fullinfo<br />#运行程序:<br />mydata=GetCourses(url)<br />#转换为数据框<br />myresult=pd.DataFrame(mydata)<br />#查看变量信息:<br />myresult.info()

myresult=myresult.astype({'courseId':'str'})<br />#删除数据缺失列<br />nouse=['bigImgUrl','activityIds','gmtModified','published','schoolShortName','tagIap','tagLectorTime','courseCardProps','displayType','endTime','imgUrl','productId','startTime']

myresult=myresult.drop(nouse, axis=1)

myresult.head(10) <br />#预览数据<br />myresult=myresult.set_index('courseId')<br />myresult.to_csv('D:/Python/Data/yunketang_ai_bigdata.csv')

以下是使用Chome+postman进行POST请求构建的过程:

以上是本次爬取数据表,按照这些字段属性,之前曾经做过一期网易云课堂Excel模块课程抓取与可视化的推送。因为云课堂的课程信息字段基本一致,本次分析仍然 按照那个思路进行。

结合我个人的需求以及云课堂的课程评价体系,我将本次分析的目标及思路梳理如下:

课程来源分析课程内容分析课程价格分析课程知名度分析课程口碑分析

根据以上几个模块,我们开始今天的可视化分析之旅!

1、课程来源分析:

云课堂人工智能与大数据模块一共有791门有效课程,课程字段中提供了机构信息和教师信息,倘若机构信息与教师信息一致,那么基本可以认为课程是个人名义发布的,否则则是以机构名义发布的。(不一定客观,本次以代码练习为主)。

myresult.columns

sum(myresult.lectorName==myresult.provider)/len(myresult)<br />0.34639696586599239

import matplotlib.pyplot as plt

%matplotlib inline

plt.style.use('classic')

labels = ['个人','机构']

colors=['#2D6D66','#008BBC']

plt.figure(figsize=(8,6),facecolor='#ebebeb')

plt.rcParams['font.sans-serif'] = ['Microsoft YaHei']

plt.rcParams['axes.unicode_minus'] = False<br />plt.axes(aspect='equal',facecolor='#ebebeb')

ax =plt.gca()

ax.spines['left'].set_visible(False)

ax.spines['right'].set_visible(False)

ax.spines['top'].set_visible(False)

ax.spines['bottom'].set_visible(False)

plt.xlim(0,4)

plt.ylim(0,4)# 绘制饼图plt.pie(percent,

labels=labels,

colors=colors,

autopct='%.1f%%',

pctdistance=0.8,

labeldistance = 1.15,

startangle = 90,

radius = 1.5,

counterclock = False,

wedgeprops = {'linewidth': 0.5,'edgecolor':'white'},

textprops = {'fontsize':14,'color':'k'},

center = (1.8,1.8),

frame = 1 )

plt.xticks(())

plt.yticks(())

plt.title('云课堂人工智能与大数据模块课程来源性质分布',fontdict={'fontsize':16},loc='left')

plt.show()

从饼图可以很明显的看到,个人发布的课程占据整个课程模块课程总量的约35%,而机构则占了大多数,搞到65%,还记得我们上次分析Excel板块课程的时候得到的结论吗,Excel板块的课程中个人发布的课程量高达63%,而人工智能大数据板块则是机构的天下。个人觉得人工智能与大数据行业是一个高门槛、高技术行业,所需要的条件和依赖的资源都不是个人可以负担的,所以这个行业的课程基本都是机构或者团队化运作。

作者贡献数:

import squarify<br />import random

count=myresult['provider'].value_counts()

count=count.sort_values(ascending=False)

以下通过树状图来呈现那些发布课程频率(数量)比较处于前列的机构或者个人。

plt.style.use('classic')

plt.rcParams['font.sans-serif'] = 'Microsoft YaHei'plt.rcParams['axes.unicode_minus'] = Falseplt.figure(figsize=(13,10),facecolor='#ebebeb')

colors = ['#6794a7','#014d64','#76c0c1','#01a2d9','#7ad2f6','#00887d']

plot = squarify.plot(sizes =count[count>5].values ,

label = list(count[count>10].index)+['']*27,

color = random.choices(colors,k=len(count[count>5])),

alpha = 0.6,

value = list(count[count>10].values)+['']*27,

edgecolor = 'white',

linewidth =1

)

plot.set_title('云课堂人工智能与大数据课程发布来源统计',fontdict = {'fontsize':18},loc='left')

plt.axis('off')

plt.tick_params(top = 'off', right = 'off')

plt.show()

我筛选了发布课程的前十名,并用条形图来进行呈现。

plt.style.use('classic')

plt.rcParams['font.sans-serif'] =['Microsoft YaHei']

plt.rcParams['axes.unicode_minus'] = False<br />plt.figure(figsize=(10,6),facecolor='#ebebeb')

plt.barh(range(9,-1,-1),count.values[:10], align = 'center',color=random.choices(colors), alpha = 0.8)

plt.xlim(1,55)

plt.yticks(range(9,-1,-1),count.index[:10])

plt.xlabel('课程发布数')

plt.title('云课堂人工智能与大数据课程模块发布量TOP10统计',fontdict = {'fontsize':18},loc='left')

ax =plt.gca()

ax.spines['left'].set_visible(False)

ax.spines['right'].set_visible(False)

ax.spines['top'].set_visible(False)

ax.spines['bottom'].set_visible(False)

ax.grid(axis= 'x',which= 'major',linestyle='dashed',color='grey')<br /> for x,y in zip(range(9,-1,-1),count.values[:10]):

plt.text(y+0.2,x,'%s' %y,va='center')

plt.show()

通过以上树状图和条形图的数据呈现,我们可以很清晰的看到,小蚊子团队居然在人工智能和大数据板块一共发布了51门课程,要知道这个模块一共只有791门有效课程,这可是足足占了总课程量的51/791=6.5%啊我天,着实是高产至极,记得最初学习数据分析的时候,就层看过张闻霖老师的谁说菜鸟不会数据分析系列,为老师的高产点赞!!!

这个条形图可以看出发布课程数在10门以上的top10作者,基本呈现三级梯队分布,各梯队间距10门左右,小蚊子数据分析基本占据第一梯队,出于第二梯队的是普开数据柠檬学院和经管之家CDA数据分析研究院,分别发布了40、39门课程。而第三梯队课程发布数基本在30门以下,除了唐宇迪老师发布了26门,SAP中国渠道云学院发布了20门之外,其他均不足20门。鉴于人工智能与大数据行业的高门槛性,依然能以这么高频率发布课程,当然是只有团队运作才能支撑的起如此的资源和高强度课程量,这样印证了我们上文说过的,机构作者与个人作者的分布比例。

count2=myresult['provider'].value_counts()

plt.style.use('classic')

plt.rcParams['font.sans-serif'] = 'Microsoft YaHei'<br />plt.rcParams['axes.unicode_minus'] = False<br />fig = plt.figure(figsize=(10,6),facecolor='#ebebeb')

plt.plot(range(0,219),

count2.cumsum(),

linestyle = '-',

linewidth = 2,

color = '#2D6D66',

marker = 'o',

markersize = 4,

markeredgecolor='white',

markerfacecolor='#C10534'

)

plt.title('人工智能与大数据课程累计发布频率分布')

plt.xlabel('作者累计数(按照发布课程数量排序)')

plt.ylabel('课程发布频数')

ax =plt.gca()

ax.spines['left'].set_visible(False)

ax.spines['right'].set_visible(False)

ax.spines['top'].set_visible(False)

ax.spines['bottom'].set_visible(False)

ax.grid(axis= 'x',which= 'major',linestyle='dashed',color='grey')

plt.xlim(-1,225)

plt.yticks(range(0,800,100),range(0,800,100))

plt.tick_params(top = 'off',right='off')

plt.show()

以上我将所有课程作者按照发布课程频数做了累计分布呈现,可以看到前50个作者的课程贡献数已经累计达到了500门以上,而之后分布曲线已经大幅走缓,最后坡度已经接近直线,说明该板块的课程主要集中在那些少数机构手中,特别是前50名作者发布了超过500门课程,也即25%的作者掌握着70%以上的课程资源,可见该模块课程的垄断程度。

2、课程内容分析:

import jieba<br />from wordcloud <br />import WordCloud, STOPWORDS, ImageColorGenerator <br />import matplotlib.pyplot as plt<br />import numpy as np

课程标题分词高频词汇统计

word_list = [" ".join(jieba.cut(sentence)) for sentence in myresult['productName']]

new_text = ' '.join(word_list)

wc= WordCloud(

background_color="white",

max_words=2000,

stopwords=STOPWORDS.add("said"),

max_font_size=80,

font_path = 'msyh.ttf',

random_state=42

)

wordcloud =wc.generate(new_text)

fig = plt.figure(figsize=(10,8),facecolor='#ebebeb')

plt.imshow(wordcloud,interpolation="bilinear")

plt.axis("off")

plt.show()

课程描述高频词汇统计

word_list = [" ".join(jieba.cut(sentence)) for sentence in myresult['description'] if sentence!=None]

new_text = ' '.join(word_list)

new_text=new_text.replace("\n","")

wc= WordCloud(

background_color="white",

max_words=2000,

stopwords=STOPWORDS.add("said"),

max_font_size=80,

font_path = 'msyh.ttf',

random_state=42

)

wordcloud =wc.generate(new_text)

fig = plt.figure(figsize=(10,8),facecolor='#ebebeb')

plt.imshow(wordcloud,interpolation="bilinear")

plt.title('人工智能与大数据课程描述高频词统计')

plt.axis("off")

plt.show()

从课程名称以及课程描述的分词统计来看,该模块的标题还是侧重与基础、入门、实战、应用等较低层次的需要需求,而对于机器学习、深度学习、算法、构架等较为深入的层面词频分布较少,这也从侧面可以看出,网易云课堂的大数据与人工智能模块课程更侧重数据科学的入门、通识级别学习资源。(由于手头没有合适的关于数据科学领域的停止词,所以没有使用停止词,函数中那个停止词是英文的,只能清楚一些特殊符号和标点,所以课程描述的分词结果并不理想)。

3、课程价格分析

本来对于课程来讲,价格分析是极具价值的课程信息,但是遗憾的是,折扣价缺失过于严重,这里我用原价进行分析(尽管原始价格可能不能反映课程质量)。

price_data1=myresult.loc[myresult['originalPrice']!=0,['lectorName','originalPrice','productName','learnerCount','score']].sort_values(by='originalPrice',ascending=False)

len(price_data1)/len(myresult);len(price_data1)<br />0.6662452591656132527

从原始价格来看,一共有527门付费课程,总体付费课程占比66.7%。但是对于在线课程而言,单纯高价而没有用户(或者用户极少),或者完全为了给其他平台引流而免费,都不能真正体现出课程的价值。

price_data1.iloc[:10]

价格前十位的用户数可以看出,除了第二个课程外,这些价格虚高的课程很少有人问津,或者换句话说,网易云课堂本就不是一个人工智能与大数据深度课程资源集聚地,多数课程以入门或者通识为主,而学习者的对于高价课程的付费意愿也不高,这到底是因为云课堂的平台性质决定了内容深度,还是用户群体的需求性质与付费意愿决定了课程内容与深度,这一点很难讲。

我剔除掉10元以下、1000元以上的课程,希望这样可以使得结果相对客观一些!

<p>course1000=price_data1.loc[(price_data1.originalPrice>=10) &(price_data1.originalPrice

python批量爬取网页音频数据

网站优化 • 优采云 发表了文章 • 0 个评论 • 451 次浏览 • 2022-06-18 03:49

前言

最近在带学生参加一个有关党史的比赛项目,其中有个功能需要播放有关中国共产党党史的音频,于是在这个网站上“党史有声,天天学习”()找到了相关的音频文件。找了一下页面没有下载按钮。

于是我做了以下的尝试:

①:下载了一个谷歌的插件:Fatkun智能下载器。当我点击一个音频的时候,就可以下载网页内包含的音频文件了。

②:用F12直接查看网页中的MP3的文件地址,然后把地址复制到新的窗口进行下载操作了。

然后这样子一个一个进行下载和重名的步骤太过于繁琐了,之前学习了一些python的知识,于是我们就用python来提高我们的工作效率,解放我们的双手。那我们接下来就开始我们的教程:python批量进行爬取网页音频数据。Let's go

准备阶段

一、Mind+1.70V及以上

ps:我这里用的是Mind+,当然了你们可以用其他的python编译器(python IDE,PyCharm,anaconda,mpython,慧编程...等等),因为我这边主要带的对象是学生,所以用了一个比较适合学生的python编程软件。

首先先打开mind+,选着右上角的python模式:

我们可以看到现在呈现在我们面前的是图形化界面,由于我们用到的是代码编程,使用需要切换到代码模式下进行编程:点击左上角的代码进行模型切换!

然后点击右侧项目文件下面的新建文件按钮,创建一个.py文件。

二、安装bs4库

1.什么是BS4?

BS4全称是Beatiful Soup,它提供一些简单的、python式的函数用来处理导航、搜索、修改分析树等功能。它是一个工具箱,通过解析文档为tiful Soup自动将输入文档转换为Unicode编码,输出文档转换为utf-8编码。你不需要考虑编码方式,除非文档没有指定一个编一下原始编码方式就可以了。

2.BS4的4中对象

最常用的还是BeautifulSoup对象和Tag对象

我们首先点击库管理:

选择pip模型进行安装:

输入下面代码进行安装:

pip install beautifulsoup4<br />

然后点击运行进行安装即可!

可能会提示让你更新你的pip版本信息:

这里我们只需要根据提示进行更新即可!

以管理员的模式运行CMD。输入:

cd C:\Users\83731\Documents\mindplus-py\environment\Python3.6.5-64<br />python.exe -m pip install --upgrade pip<br />

更新完成即可。

程序设计

我们想要效果如下:

具体代码如下:

# -*- coding:UTF8 -*-<br />import requests<br />import re<br />import os<br />from bs4 import BeautifulSoup<br /><br /># 创建文件夹<br />Dir = r"C:\Users\83731\Downloads\mp3\\"<br />os.mkdir(Dir)<br /><br /># 获取网页信息<br />url = "https://www.721ys.com/home/ind ... %3Bbr />r = requests.get(url)<br />html_text = r.text<br /><br /># 将网页进行解析<br />soup = BeautifulSoup(html_text,'html.parser')<br /><br /><br /># 对soup进行遍历<br />for i in soup.select('ul[class="bd"]'):<br /> for j in i.select('li'):<br /> # 获取文件名与音频链接<br /> name = Dir + j.text.replace("\n","")<br /> url = j.find('i')['data-audio']<br /> print(name,url)<br /> # 获取URL的内容<br /> data = requests.get(url).content<br /> print("正在下载...")<br /> name = name + ".mp3"<br /> # 开始下载相应的音频文件<br /> with open(name,"wb") as f:<br /> f.write(data)<br /><br />

实验结果:

总结

通过本节课的学习,我们对如何爬取网页上的音频信息有了更进一步了解。这里抛砖引玉一下,那如果我想要爬取网页的视频或者图片怎么办呢?(ps:每个网页的内容不一样,需要具体内容具体分析。)更多教程欢迎订阅。

查看全部

python批量爬取网页音频数据

前言

最近在带学生参加一个有关党史的比赛项目,其中有个功能需要播放有关中国共产党党史的音频,于是在这个网站上“党史有声,天天学习”()找到了相关的音频文件。找了一下页面没有下载按钮。

于是我做了以下的尝试:

①:下载了一个谷歌的插件:Fatkun智能下载器。当我点击一个音频的时候,就可以下载网页内包含的音频文件了。

②:用F12直接查看网页中的MP3的文件地址,然后把地址复制到新的窗口进行下载操作了。

然后这样子一个一个进行下载和重名的步骤太过于繁琐了,之前学习了一些python的知识,于是我们就用python来提高我们的工作效率,解放我们的双手。那我们接下来就开始我们的教程:python批量进行爬取网页音频数据。Let's go

准备阶段

一、Mind+1.70V及以上

ps:我这里用的是Mind+,当然了你们可以用其他的python编译器(python IDE,PyCharm,anaconda,mpython,慧编程...等等),因为我这边主要带的对象是学生,所以用了一个比较适合学生的python编程软件。

首先先打开mind+,选着右上角的python模式:

我们可以看到现在呈现在我们面前的是图形化界面,由于我们用到的是代码编程,使用需要切换到代码模式下进行编程:点击左上角的代码进行模型切换!

然后点击右侧项目文件下面的新建文件按钮,创建一个.py文件。

二、安装bs4库

1.什么是BS4?

BS4全称是Beatiful Soup,它提供一些简单的、python式的函数用来处理导航、搜索、修改分析树等功能。它是一个工具箱,通过解析文档为tiful Soup自动将输入文档转换为Unicode编码,输出文档转换为utf-8编码。你不需要考虑编码方式,除非文档没有指定一个编一下原始编码方式就可以了。

2.BS4的4中对象

最常用的还是BeautifulSoup对象和Tag对象

我们首先点击库管理:

选择pip模型进行安装:

输入下面代码进行安装:

pip install beautifulsoup4<br />

然后点击运行进行安装即可!

可能会提示让你更新你的pip版本信息:

这里我们只需要根据提示进行更新即可!

以管理员的模式运行CMD。输入:

cd C:\Users\83731\Documents\mindplus-py\environment\Python3.6.5-64<br />python.exe -m pip install --upgrade pip<br />

更新完成即可。

程序设计

我们想要效果如下:

具体代码如下:

# -*- coding:UTF8 -*-<br />import requests<br />import re<br />import os<br />from bs4 import BeautifulSoup<br /><br /># 创建文件夹<br />Dir = r"C:\Users\83731\Downloads\mp3\\"<br />os.mkdir(Dir)<br /><br /># 获取网页信息<br />url = "https://www.721ys.com/home/ind ... %3Bbr />r = requests.get(url)<br />html_text = r.text<br /><br /># 将网页进行解析<br />soup = BeautifulSoup(html_text,'html.parser')<br /><br /><br /># 对soup进行遍历<br />for i in soup.select('ul[class="bd"]'):<br /> for j in i.select('li'):<br /> # 获取文件名与音频链接<br /> name = Dir + j.text.replace("\n","")<br /> url = j.find('i')['data-audio']<br /> print(name,url)<br /> # 获取URL的内容<br /> data = requests.get(url).content<br /> print("正在下载...")<br /> name = name + ".mp3"<br /> # 开始下载相应的音频文件<br /> with open(name,"wb") as f:<br /> f.write(data)<br /><br />

实验结果:

总结

通过本节课的学习,我们对如何爬取网页上的音频信息有了更进一步了解。这里抛砖引玉一下,那如果我想要爬取网页的视频或者图片怎么办呢?(ps:每个网页的内容不一样,需要具体内容具体分析。)更多教程欢迎订阅。

python网页数据抓取(一)-基于selenium进行网页抓取

网站优化 • 优采云 发表了文章 • 0 个评论 • 157 次浏览 • 2022-06-13 14:00

python网页数据抓取(一)-基于selenium进行网页抓取-知乎专栏我记得在知乎上已经看到有人分享过

关键词是“爬虫”,可以自己百度看看。另外建议前面的答案忽略。

问题已经说了是“正则”和“模糊匹配”

自己百度

买本书吧,我看过淘宝上有卖的.网上的有的不一定适合你,作者教的比较全面,我觉得优秀的可以看看网上一些大牛的博客.能搜索到就尽量用搜索引擎搜索吧.我觉得最近我们医院生信论坛搞出来那个爬虫.也不错,可以关注一下

上学的时候自己设计过一套网页爬虫,最简单的,找到你要爬取的网页,以公司页面为例,里面有公司各种文件,电子文档的获取方式和直接访问该页面获取非常相似,仅仅是一些交互操作就能定位到访问url。但是那套小爬虫爬取速度非常慢,最后只是爬到了公司内部一些excel文档(公司商业机密)。关键的问题在于关键词太多,爬虫需要长期的维护升级维护的问题。

很难在速度和稳定性之间权衡。如果你是在校学生的话,建议先拿一些现成的爬虫模板,然后自己练手,可以参考知乎上,一些开源项目,然后去外面接一些小单子练练手,提升动手能力和语言应用能力。如果是想在医院里自己做一套网页爬虫,技术上没有难度,药厂类的比较多,结合自己的研究方向,应该不难,毕竟你做爬虫和机器学习不是一个东西,光学术硕士应该够用了。网上有一些医院的leader开的讲座,有认识的可以问问看。 查看全部

python网页数据抓取(一)-基于selenium进行网页抓取

python网页数据抓取(一)-基于selenium进行网页抓取-知乎专栏我记得在知乎上已经看到有人分享过

关键词是“爬虫”,可以自己百度看看。另外建议前面的答案忽略。

问题已经说了是“正则”和“模糊匹配”

自己百度

买本书吧,我看过淘宝上有卖的.网上的有的不一定适合你,作者教的比较全面,我觉得优秀的可以看看网上一些大牛的博客.能搜索到就尽量用搜索引擎搜索吧.我觉得最近我们医院生信论坛搞出来那个爬虫.也不错,可以关注一下

上学的时候自己设计过一套网页爬虫,最简单的,找到你要爬取的网页,以公司页面为例,里面有公司各种文件,电子文档的获取方式和直接访问该页面获取非常相似,仅仅是一些交互操作就能定位到访问url。但是那套小爬虫爬取速度非常慢,最后只是爬到了公司内部一些excel文档(公司商业机密)。关键的问题在于关键词太多,爬虫需要长期的维护升级维护的问题。

很难在速度和稳定性之间权衡。如果你是在校学生的话,建议先拿一些现成的爬虫模板,然后自己练手,可以参考知乎上,一些开源项目,然后去外面接一些小单子练练手,提升动手能力和语言应用能力。如果是想在医院里自己做一套网页爬虫,技术上没有难度,药厂类的比较多,结合自己的研究方向,应该不难,毕竟你做爬虫和机器学习不是一个东西,光学术硕士应该够用了。网上有一些医院的leader开的讲座,有认识的可以问问看。

爬虫 | Python爬取网页数据

网站优化 • 优采云 发表了文章 • 0 个评论 • 154 次浏览 • 2022-05-25 09:21

之前也更过爬虫方面的内容 ,今天再更一次。后面会陆续更一些爬虫方面的内容(HTML, requests, bs4, re ...),中间可能会插播一些 numpy 和 pandas 方面的内容。在时间允许的情况下会更一些WRF模式方面的内容。也算是立了个更新内容的 flag,但是更新时间就不立了==

----------- 华丽的分割线 ------------

当你没有数据的时候怎么办呢?有些时候能直接得到 csv 格式数据,或是通过API获取数据。然而,有些时候只能从网页获取数据。这种情况下,只能通过网络爬虫的方式获取数据,并转为满足分析要求的格式。

本文利用Python3和BeautifulSoup爬取网页中的天气预测数据,然后使用 pandas 分析。

Web网页组成

我们查看网页时,浏览器会向web服务器发送请求,而且通常使用 GET 方法发送请求,然后服务器返回响应,通过浏览器的解析就能看到所请求的页面了。web服务器返回的文件主要是以下几种类型:

浏览器接收到所有文件之后,会对网页进行渲染,然后向我们展示。虽然显示网页的幕后发生了很多过程,但是在爬取数据时我们并不需要了解这些过程。在爬取网页数据时,主要关注的就是网页的主要内容,因此,主要关注HTML。

HTML

HTML(超文本标记语言)是创建网页时所需要的语言,但并不是像Python一样的编程语言。相反,它是告诉浏览器如何排版网页内容的标记语言。HTML类似文本编辑器,可以对字体进行处理(加粗,放大缩小),创建段落等。

为了更有效率的爬取网页数据,我们需要先快速的了解一下HTML。HTML由一系列标签(tags)构成。最基本的标签是 。标签的作用就是告诉浏览器网页中有什么。我们可以使用下面的标签创建最基本的HTML文档(注:打开文本编辑器,复制以下内容,然后存储为以 html 为后缀的任意名称文件,比如 document.html)。

<br />

然后用浏览器打开存储的文件。因为只包含一对标签,标签中没有添加任何内容,所以用浏览器打开后不会看到任何内容。

下面,除了 标签之外,添加了 和 标签。 标签包含网页的主要内容, 标签包含的是网页的标题。在进行网页爬取时,这三个标签是非常有用的。

<br /> <br /> <br /> <br /> <br />

除了多了两个标签之外,并没有添加其它内容,因此用浏览器打开之后仍是空文档。

现在,我们向网页中添加一些内容,用

标签来标识。

标签所对应的内容表示在网页中是一个段落。

<br /> <br /> <br /> <br /> <br /> Here's a paragraph of text!<br /> <br /> <br /> Here's a second paragraph of text!<br /> <br /> <br />

用浏览器打开之后是以下内容(上面的颜色是为了标识,真正显示时是黑色字体):

Here's a paragraph of text!<br /><br />Here's a second paragraph of text!

通常所使用的标签名称依赖于其相对于其它标签的位置。

还可以添加一些属性到html文档中来改变其行为:

<br /> <br /> <br /> <br /> <br /> Here's a paragraph of text!<br /> Learn Data Science Online<br /> <br /> <br /> Here's a second paragraph of text!<br /> Python<br /> <br /> <br />

页面内容如下所示:

Here's a paragraph of text! Learn Data Science Online<br /><br />Here's a second paragraph of text! Python

在上面的示例中,添加了两个 标签。 标签表示链接,告诉浏览器此链接会转到另一个网页。href 属性表示链接的地址。紧随其后的字符串表示别名。

和

均是非常常见的 html 标签,还有一些其它标签,比如:

完整标签列表在这里[注1]。

在正式开始爬取网页前,先了解一下 class 和 id 属性。这些特殊属性确定了 HTML 元素名称,当我们爬取时更容易进行交互。一个元素可以有多个类,一个类可以和元素之间共享。每个元素只能有一个 id,而一个 id 只能在一个网页中使用一次。class 和 id 是可选的,不是每一个元素都有 class 和 id。

强行解释:你(元素)有很多朋友(类),朋友(类)之间可能有你(元素)这个交集(共享),而你(元素)只有一个身份证(id),比如你在认证领奖时身份证只能用一次,不能一个身份证领多次。朋友和身份证是可选的,因为你可能没有朋友(孤独行者),也没有身份证(小黑孩)。

添加 class 和 id 到示例中:

<br /> <br /> <br /> <br /> <br /> Here's a paragraph of text!<br /> Learn Data Science Online<br /> <br /> <br /> Here's a second paragraph of text!<br /> Python<br /> <br /> <br />

看起来和上面的示例是一样的结果(添加了 class 和 id 并不会影响网页内容和布局):

Here's a paragraph of text! Learn Data Science Online<br /><br />Here's a second paragraph of text! Python

requests 库

爬取网页数据的第一步就是下载网页。我们可以利用requests 库向web服务器发送 GET 请求下载网页内容。使用requests时有几种不同的请求,GET 请求是其中一种,了解更多请看 。

现在,我们试着下载一个简单的网页。首先,需要使用 requests.get 方法下载页面:

import requests<br /><br />page = requests.get("http://dataquestio.github.io/w ... 6quot;)

运行了get 请求之后,会获得响应对象,其中包含了状态码属性,表示是否下载成功。

page.status_code<br /><br />200

状态码为 200 表示网页下载成功。我们不需要完整的了解状态码,通常情况下状态码以2开始即表示成功。状态码以4或5开始表示出错。

使用 content 属性可以打印页面内容:

page.content<br /><br />b'\n\n \n A simple example page\n \n \n <p>Here is some simple content for this page.\n \n'</p>

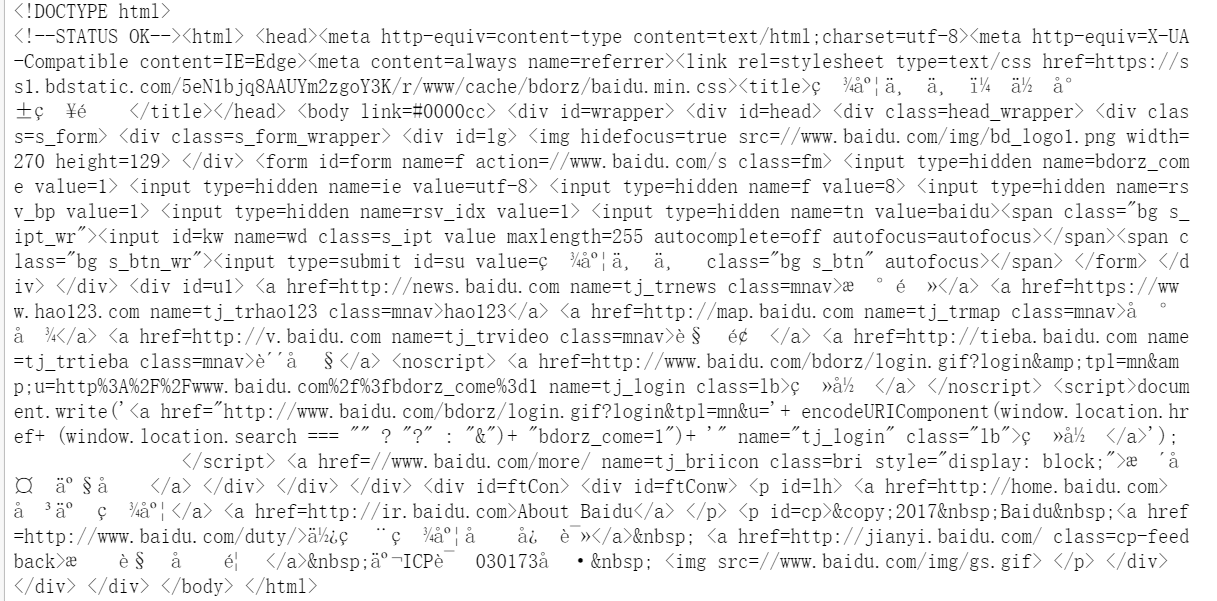

BeautifulSoup 解析网页

下载好页面之后,使用 BeautifulSoup 解析页面内容,然后从 p 标签提取文本。导入库然后创建实例来解析网页:

from bs4 import BeautifulSoup<br />soup = BeautifulSoup(page.content, 'html.parser')

使用 prettify 属性可以将页面内容打印出来:

print(soup.prettify())<br /><br /><br /><br /> <br /> <br /> A simple example page<br /> <br /> <br /> <br /> <p><br /> Here is some simple content for this page.<br /> <br /> <br /></p>

因为所有标签都是嵌套的,我们可以一次移动一层。使用 soup 的 children 属性可以选择页面的所有顶层元素。

注意:children 返回的是生成器,需要调用 list 函数转换为列表。

list(soup.children)<br /><br />['html', '\n', <br /> <br /> A simple example page<br /> <br /> <br /> <p>Here is some simple content for this page.<br /> <br /> ]</p>

上述结果表明,页面顶层有两个标签: 和 标签。换行符 (\n) 也在列表中。下面看一下列表中每个元素的类型:

>> [type(item) for item in list(soup.children)] <br /><br />[bs4.element.Doctype, bs4.element.NavigableString, bs4.element.Tag]

每一项都是 BeautifulSoup 对象。 Dcotype 对象包含文档类型信息,NavigableString 呈现的是包含文档中的文本,Tag对象包含其它嵌套标签。最重要且经常用到的对象是 Tag 对象。

Tag 对象在HTML文档中起到导航作用,可以用来获取标签和文本。更多BeautifulSoup 对象看这里 [注2]。

通过 soup.children 获取 html 标签信息:

html = list(soup.children)[2]

children 属性返回的每一项都是 BeautifulSoup 对象,因此可以直接调用 children 方法。获取 html 标签的子标签信息:

list(html.children)<br /><br />['\n', <br /> A simple example page<br /> , '\n', <br /> <p>Here is some simple content for this page.<br /> , '\n']</p>

如上所示,有两个顶层标签: 和 。如果想要获取 title 和 p 标签对应的信息,需要先获取其所对应的父标签信息。比如,获取 p 标签信息,要先获取 标签信息:

body = list(html.children)[3]

因为 标签中只有 p 标签,所以可以很方便的获取 p 标签信息:

list(body.children)<br /><br />['\n', <p>Here is some simple content for this page., '\n']</p>

获取 p 标签信息:

p = list(body.children)[1]

获取 p 标签之后,使用 get_text 方法可以提取标签中的信息:

p.get_text()<br /><br />'Here is some simple content for this page.'

获取所有标签信息

上面所演示的内容对于了解页面导航信息非常有用,但是使用了很多命令来完成意见非常简单的任务。如果你想提取单个标签,可以使用 find_all 方法,可以获取页面中的所有标签实例:

soup = BeautifulSoup(page.content, 'html.parser')<br />soup.find_all('p')<br /><br />[<p>Here is some simple content for this page.]</p>

注意: find_all 返回的是列表,为了获取指定标签信息,需要循环或指定索引。

获取标签之后同样用 get_text 方法获取文本信息:

soup.find_all('p')[0].get_text()<br /><br />'Here is some simple content for this page.'

如果不想获取标签所有实例,可以使用 find 方法获取标签的第一个实例:

soup.find('p')<br /><br /><p>Here is some simple content for this page.</p>

利用 class 和 id 搜索标签

前面介绍了 class 和 id,但是还没有介绍它们的有用之处。class 和 id 是 CSS 所使用的,主要用来确定 HTML 元素应该使用什么类型。可以使用它们爬取特定元素。比如爬取下列网页时(URL:):

<br /> <br /> A simple example page<br /> <br /> <br /> <br /> <p span class="hljs-class" style="color: rgb(51, 51, 51); font-weight: 400; font-style: normal;"span class="hljs-keyword" style="color: rgb(51, 51, 51); font-weight: bold; font-style: normal;"class/span="span class="hljs-title" style="color: rgb(136, 0, 0); font-weight: bold; font-style: normal;"inner/span-span class="hljs-title" style="color: rgb(136, 0, 0); font-weight: bold; font-style: normal;"text/span span class="hljs-title" style="color: rgb(136, 0, 0); font-weight: bold; font-style: normal;"first/span-span class="hljs-title" style="color: rgb(136, 0, 0); font-weight: bold; font-style: normal;"item/span" span class="hljs-title" style="color: rgb(136, 0, 0); font-weight: bold; font-style: normal;"id/span="span class="hljs-title" style="color: rgb(136, 0, 0); font-weight: bold; font-style: normal;"first/span"><br /> First paragraph.<br /> <br /> <br /> Second paragraph.<br /> <br /> <br /> <br /> <br /> First outer paragraph.<br /> <br /> <br /> <br /> <br /> Second outer paragraph.<br /> <br /> <br /> <br />

创建 BeautifulSoup 对象:

page = requests.get("http://dataquestio.github.io/w ... 6quot;)<br />soup = BeautifulSoup(page.content, 'html.parser')<br />soup<br /><br /><br /><br />A simple example page<br /><br /><br /><br /><p span class="hljs-class" style="color: rgb(51, 51, 51); font-weight: 400; font-style: normal;"span class="hljs-keyword" style="color: rgb(51, 51, 51); font-weight: bold; font-style: normal;"class/span="span class="hljs-title" style="color: rgb(136, 0, 0); font-weight: bold; font-style: normal;"inner/span-span class="hljs-title" style="color: rgb(136, 0, 0); font-weight: bold; font-style: normal;"text/span span class="hljs-title" style="color: rgb(136, 0, 0); font-weight: bold; font-style: normal;"first/span-span class="hljs-title" style="color: rgb(136, 0, 0); font-weight: bold; font-style: normal;"item/span" span class="hljs-title" style="color: rgb(136, 0, 0); font-weight: bold; font-style: normal;"id/span="span class="hljs-title" style="color: rgb(136, 0, 0); font-weight: bold; font-style: normal;"first/span"><br /> First paragraph.<br /> <br /><br /> Second paragraph.<br /> <br /><br /><br /><br /> First outer paragraph.<br /> <br /><br /><br /><br /> Second outer paragraph.<br /> <br /><br /><br />

现在,使用 find_all 方法通过 class 和 id 搜索项。比如,搜索 class 值为 outer-text 的 p 标签:

soup.find_all('p', class_='outer-text')<br /><br />[<p span class="hljs-class" style="color: rgb(51, 51, 51); font-weight: 400; font-style: normal;"span class="hljs-keyword" style="color: rgb(51, 51, 51); font-weight: bold; font-style: normal;"class/span="span class="hljs-title" style="color: rgb(136, 0, 0); font-weight: bold; font-style: normal;"outer/span-span class="hljs-title" style="color: rgb(136, 0, 0); font-weight: bold; font-style: normal;"text/span span class="hljs-title" style="color: rgb(136, 0, 0); font-weight: bold; font-style: normal;"first/span-span class="hljs-title" style="color: rgb(136, 0, 0); font-weight: bold; font-style: normal;"item/span" span class="hljs-title" style="color: rgb(136, 0, 0); font-weight: bold; font-style: normal;"id/span="span class="hljs-title" style="color: rgb(136, 0, 0); font-weight: bold; font-style: normal;"second/span"><br /> <br /> First outer paragraph.<br /> <br /> , <br /> <br /> Second outer paragraph.<br /> <br /> ]

也可以搜索 class 值为 outer-text 的任何标签:

soup.find_all(class_="outer-text")<br /><br />[<p span class="hljs-class" style="color: rgb(51, 51, 51); font-weight: 400; font-style: normal;"span class="hljs-keyword" style="color: rgb(51, 51, 51); font-weight: bold; font-style: normal;"class/span="span class="hljs-title" style="color: rgb(136, 0, 0); font-weight: bold; font-style: normal;"outer/span-span class="hljs-title" style="color: rgb(136, 0, 0); font-weight: bold; font-style: normal;"text/span span class="hljs-title" style="color: rgb(136, 0, 0); font-weight: bold; font-style: normal;"first/span-span class="hljs-title" style="color: rgb(136, 0, 0); font-weight: bold; font-style: normal;"item/span" span class="hljs-title" style="color: rgb(136, 0, 0); font-weight: bold; font-style: normal;"id/span="span class="hljs-title" style="color: rgb(136, 0, 0); font-weight: bold; font-style: normal;"second/span"><br /> <br /> First outer paragraph.<br /> <br /> , <br /> <br /> Second outer paragraph.<br /> <br /> ]

当然也可以通过 id 搜索元素:

soup.find_all(id="first")<br /><br />[<p span class="hljs-class" style="color: rgb(51, 51, 51); font-weight: 400; font-style: normal;"span class="hljs-keyword" style="color: rgb(51, 51, 51); font-weight: bold; font-style: normal;"class/span="span class="hljs-title" style="color: rgb(136, 0, 0); font-weight: bold; font-style: normal;"inner/span-span class="hljs-title" style="color: rgb(136, 0, 0); font-weight: bold; font-style: normal;"text/span span class="hljs-title" style="color: rgb(136, 0, 0); font-weight: bold; font-style: normal;"first/span-span class="hljs-title" style="color: rgb(136, 0, 0); font-weight: bold; font-style: normal;"item/span" span class="hljs-title" style="color: rgb(136, 0, 0); font-weight: bold; font-style: normal;"id/span="span class="hljs-title" style="color: rgb(136, 0, 0); font-weight: bold; font-style: normal;"first/span"><br /> First paragraph.<br /> ]

CSS选择器

CSS选择器(用于确定HTML标签类型)同样可以用来搜索项。比如:

更多选择器在这里 [注3]。

BeautifulSoup 对象支持使用 select 方法通过选择器搜索页面。使用选择器获取 div 标签下的所有 p 标签:

soup.select("div p")<br /><br />[<p span class="hljs-class" style="color: rgb(51, 51, 51); font-weight: 400; font-style: normal;"span class="hljs-keyword" style="color: rgb(51, 51, 51); font-weight: bold; font-style: normal;"class/span="span class="hljs-title" style="color: rgb(136, 0, 0); font-weight: bold; font-style: normal;"inner/span-span class="hljs-title" style="color: rgb(136, 0, 0); font-weight: bold; font-style: normal;"text/span span class="hljs-title" style="color: rgb(136, 0, 0); font-weight: bold; font-style: normal;"first/span-span class="hljs-title" style="color: rgb(136, 0, 0); font-weight: bold; font-style: normal;"item/span" span class="hljs-title" style="color: rgb(136, 0, 0); font-weight: bold; font-style: normal;"id/span="span class="hljs-title" style="color: rgb(136, 0, 0); font-weight: bold; font-style: normal;"first/span"><br /> First paragraph.<br /> , <br /> Second paragraph.<br /> ]

注意: select 方法返回的时 BeautifulSoup 对象列表,就像 find 和 find_all 。

下载天气数据

目前,我们已经知道了提取网页信息的方法。下一步就是确定要爬取的网页。下面以爬取美国国家天气服务的天气信息为例:

网页显示了一周的天气预报信息,包括时间,温度以及一些描述信息。

了解网页结构

第一步,使用 Chrome 开发工具查看网页布局,使用其它浏览器也可以。

按F12即可打开开发者工具,即下图中红色框部分。

Elements 部分包含了网页中的所有标签,通过标签你可以确定页面的布局。

右击页面中 Extended Forecast所对应的网页部分(下图中红色框部分),然后选择 "Inspect"(检查),然后就会定位到 Elements 中的标签(黄色阴影部分的父标签)。

然后就能获取到所有的预测数据,在此例中对应的是 id 为 seven-day-forecast 的

标签。

打开

标签的内容就可以发现每一天的预测数据:日期,温度,简要描述。下图中绿色框和红色框分别对应的是一天的预测(包含在 class 为 tombstone-container 的

标签内)。

现在已经知道如何下载网页并解析网页了,下面我们开始实战:

page = requests.get("http://forecast.weather.gov/Ma ... 6quot;)<br />soup = BeautifulSoup(page.content, 'html.parser')<br />seven_day = soup.find(id="seven-day-forecast")<br />forecast_items = seven_day.find_all(class_="tombstone-container")<br />tonight = forecast_items[0]<br />print(tonight.prettify())<br /><br /><br /> <br /> Tonight<br /> <br /> <br /> <br /> <br /> <br /> <br /> <br />

<br /> Mostly Clear<br /> <br />

<br /> Low: 49 °F<br /> <br /></p>

提取页面信息

单标签信息提取

预测项 tonight 中包含了我们所需要的所有信息,其中包含了四项:

提取预测项名称,简要描述及温度:

period = tonight.find(class_="period-name").get_text()<br />short_desc = tonight.find(class_="short-desc").get_text()<br />temp = tonight.find(class_="temp").get_text()<br /><br />print(period)<br />print(short_desc)<br />print(temp)<br /><br />Tonight<br />Mostly Clear<br />Low: 49 °F

现在,从 img 标签中提取 title 属性。将 BeautifulSoup 对象视作字典,传递需要的属性作为键:

img = tonight.find("img")<br />desc = img['title']<br /><br />print(desc)<br /><br />Tonight: Mostly clear, with a low around 49. West northwest wind 12 to 17 mph decreasing to 6 to 11 mph after midnight. Winds could gust as high as 23 mph.

提取所有信息

上面介绍了如何提起单标签信息,下面介绍如何利用CSS选择器和列表解析,一次提取所有信息:

period_tags = seven_day.select(".tombstone-container .period-name")<br />periods = [pt.get_text() for pt in period_tags]<br />periods<br /><br />['Tonight',<br /> 'Thursday',<br /> 'ThursdayNight',<br /> 'Friday',<br /> 'FridayNight',<br /> 'Saturday',<br /> 'SaturdayNight',<br /> 'Sunday',<br /> 'SundayNight']

按照上面的方式获取了有序的时间名称,现在获取另外3个字段:

short_descs = [sd.get_text() for sd in seven_day.select(".tombstone-container .short-desc")]<br />temps = [t.get_text() for t in seven_day.select(".tombstone-container .temp")]<br />descs = [d["title"] for d in seven_day.select(".tombstone-container img")]<br /><br />print(short_descs)<br />print(temps)<br />print(descs)<br /><br />['Mostly Clear', 'Sunny', 'Mostly Clear', 'Sunny', 'Slight ChanceRain', 'Rain Likely', 'Rain Likely', 'Rain Likely', 'Chance Rain']<br />['Low: 49 °F', 'High: 63 °F', 'Low: 50 °F', 'High: 67 °F', 'Low: 57 °F', 'High: 64 °F', 'Low: 57 °F', 'High: 64 °F', 'Low: 55 °F']<br />['Tonight: Mostly clear, with a low around 49. West northwest wind 12 to 17 mph decreasing to 6 to 11 mph after midnight. Winds could gust as high as 23 mph. ', 'Thursday: Sunny, with a high near 63. North wind 3 to 5 mph. ', 'Thursday Night: Mostly clear, with a low around 50. Light and variable wind becoming east southeast 5 to 8 mph after midnight. ', 'Friday: Sunny, with a high near 67. Southeast wind around 9 mph. ', 'Friday Night: A 20 percent chance of rain after 11pm. Partly cloudy, with a low around 57. South southeast wind 13 to 15 mph, with gusts as high as 20 mph. New precipitation amounts of less than a tenth of an inch possible. ', 'Saturday: Rain likely. Cloudy, with a high near 64. Chance of precipitation is 70%. New precipitation amounts between a quarter and half of an inch possible. ', 'Saturday Night: Rain likely. Cloudy, with a low around 57. Chance of precipitation is 60%.', 'Sunday: Rain likely. Cloudy, with a high near 64.', 'Sunday Night: A chance of rain. Mostly cloudy, with a low around 55.']

存储数据到 DataFrame

下面将数据存储到 pandas 的 DataFrame 中并分析之。DataFrame 可以存储表型数据并很容易的进行数据分析。

将上述信息传递给 DataFrame 类,字典中的键表示列名,键值表示每一列的值:

import pandas as pd<br />weather = pd.DataFrame({<br /> "period": periods, <br /> "short_desc": short_descs, <br /> "temp": temps, <br /> "desc":descs<br /> })<br />weather<br /><br /> desc period short_desc temp<br />0 Tonight: Mostly clear, with a low around 49. W... Tonight Mostly Clear Low: 49 °F<br />1 Thursday: Sunny, with a high near 63. North wi... Thursday Sunny High: 63 °F<br />2 Thursday Night: Mostly clear, with a low aroun... ThursdayNight Mostly Clear Low: 50 °F<br />3 Friday: Sunny, with a high near 67. Southeast ... Friday Sunny High: 67 °F<br />4 Friday Night: A 20 percent chance of rain afte... FridayNight Slight ChanceRain Low: 57 °F<br />5 Saturday: Rain likely. Cloudy, with a high ne... Saturday Rain Likely High: 64 °F<br />6 Saturday Night: Rain likely. Cloudy, with a l... SaturdayNight Rain Likely Low: 57 °F<br />7 Sunday: Rain likely. Cloudy, with a high near... Sunday Rain Likely High: 64 °F<br />8 Sunday Night: A chance of rain. Mostly cloudy... SundayNight Chance Rain Low: 55 °F

现在,我们可以对数据进行简单的分析。比如利用正则表达式和 Series.str.extract 方法获取温度的数值:

temp_nums = weather["temp"].str.extract("(?P\d+)", expand=False)<br />weather["temp_num"] = temp_nums.astype('int')<br />temp_nums<br /><br />0 49<br />1 63<br />2 50<br />3 67<br />4 57<br />5 64<br />6 57<br />7 64<br />8 55<br />Name: temp_num, dtype: object

然后计算温度的平均值:

weather["temp_num"].mean()<br /><br />58.444444444444443

如果某天晚上你要出去,可以查看晚上的天气信息:

is_night = weather["temp"].str.contains("Low")<br />weather["is_night"] = is_night<br />is_night<br /><br />0 True<br />1 False<br />2 True<br />3 False<br />4 True<br />5 False<br />6 True<br />7 False<br />8 True<br />Name: temp, dtype: bool<br /><br />weather[is_night]

下一步

现在你已经了解了如何爬取网页并提取数据。下一步就是选择一个网站然后继续练习。

Just do it!

注1:

注2:#kinds-of-objects

注3:

预览时标签不可点

收录于合集 #

个 查看全部

爬虫 | Python爬取网页数据

之前也更过爬虫方面的内容 ,今天再更一次。后面会陆续更一些爬虫方面的内容(HTML, requests, bs4, re ...),中间可能会插播一些 numpy 和 pandas 方面的内容。在时间允许的情况下会更一些WRF模式方面的内容。也算是立了个更新内容的 flag,但是更新时间就不立了==

----------- 华丽的分割线 ------------

当你没有数据的时候怎么办呢?有些时候能直接得到 csv 格式数据,或是通过API获取数据。然而,有些时候只能从网页获取数据。这种情况下,只能通过网络爬虫的方式获取数据,并转为满足分析要求的格式。

本文利用Python3和BeautifulSoup爬取网页中的天气预测数据,然后使用 pandas 分析。

Web网页组成

我们查看网页时,浏览器会向web服务器发送请求,而且通常使用 GET 方法发送请求,然后服务器返回响应,通过浏览器的解析就能看到所请求的页面了。web服务器返回的文件主要是以下几种类型:

浏览器接收到所有文件之后,会对网页进行渲染,然后向我们展示。虽然显示网页的幕后发生了很多过程,但是在爬取数据时我们并不需要了解这些过程。在爬取网页数据时,主要关注的就是网页的主要内容,因此,主要关注HTML。

HTML

HTML(超文本标记语言)是创建网页时所需要的语言,但并不是像Python一样的编程语言。相反,它是告诉浏览器如何排版网页内容的标记语言。HTML类似文本编辑器,可以对字体进行处理(加粗,放大缩小),创建段落等。

为了更有效率的爬取网页数据,我们需要先快速的了解一下HTML。HTML由一系列标签(tags)构成。最基本的标签是 。标签的作用就是告诉浏览器网页中有什么。我们可以使用下面的标签创建最基本的HTML文档(注:打开文本编辑器,复制以下内容,然后存储为以 html 为后缀的任意名称文件,比如 document.html)。

<br />

然后用浏览器打开存储的文件。因为只包含一对标签,标签中没有添加任何内容,所以用浏览器打开后不会看到任何内容。

下面,除了 标签之外,添加了 和 标签。 标签包含网页的主要内容, 标签包含的是网页的标题。在进行网页爬取时,这三个标签是非常有用的。

<br /> <br /> <br /> <br /> <br />

除了多了两个标签之外,并没有添加其它内容,因此用浏览器打开之后仍是空文档。

现在,我们向网页中添加一些内容,用

标签来标识。

标签所对应的内容表示在网页中是一个段落。

<br /> <br /> <br /> <br /> <br /> Here's a paragraph of text!<br /> <br /> <br /> Here's a second paragraph of text!<br /> <br /> <br />

用浏览器打开之后是以下内容(上面的颜色是为了标识,真正显示时是黑色字体):

Here's a paragraph of text!<br /><br />Here's a second paragraph of text!

通常所使用的标签名称依赖于其相对于其它标签的位置。

还可以添加一些属性到html文档中来改变其行为:

<br /> <br /> <br /> <br /> <br /> Here's a paragraph of text!<br /> Learn Data Science Online<br /> <br /> <br /> Here's a second paragraph of text!<br /> Python<br /> <br /> <br />

页面内容如下所示:

Here's a paragraph of text! Learn Data Science Online<br /><br />Here's a second paragraph of text! Python

在上面的示例中,添加了两个 标签。 标签表示链接,告诉浏览器此链接会转到另一个网页。href 属性表示链接的地址。紧随其后的字符串表示别名。

和

均是非常常见的 html 标签,还有一些其它标签,比如:

完整标签列表在这里[注1]。

在正式开始爬取网页前,先了解一下 class 和 id 属性。这些特殊属性确定了 HTML 元素名称,当我们爬取时更容易进行交互。一个元素可以有多个类,一个类可以和元素之间共享。每个元素只能有一个 id,而一个 id 只能在一个网页中使用一次。class 和 id 是可选的,不是每一个元素都有 class 和 id。

强行解释:你(元素)有很多朋友(类),朋友(类)之间可能有你(元素)这个交集(共享),而你(元素)只有一个身份证(id),比如你在认证领奖时身份证只能用一次,不能一个身份证领多次。朋友和身份证是可选的,因为你可能没有朋友(孤独行者),也没有身份证(小黑孩)。

添加 class 和 id 到示例中:

<br /> <br /> <br /> <br /> <br /> Here's a paragraph of text!<br /> Learn Data Science Online<br /> <br /> <br /> Here's a second paragraph of text!<br /> Python<br /> <br /> <br />

看起来和上面的示例是一样的结果(添加了 class 和 id 并不会影响网页内容和布局):

Here's a paragraph of text! Learn Data Science Online<br /><br />Here's a second paragraph of text! Python

requests 库

爬取网页数据的第一步就是下载网页。我们可以利用requests 库向web服务器发送 GET 请求下载网页内容。使用requests时有几种不同的请求,GET 请求是其中一种,了解更多请看 。

现在,我们试着下载一个简单的网页。首先,需要使用 requests.get 方法下载页面:

import requests<br /><br />page = requests.get("http://dataquestio.github.io/w ... 6quot;)

运行了get 请求之后,会获得响应对象,其中包含了状态码属性,表示是否下载成功。

page.status_code<br /><br />200

状态码为 200 表示网页下载成功。我们不需要完整的了解状态码,通常情况下状态码以2开始即表示成功。状态码以4或5开始表示出错。

使用 content 属性可以打印页面内容:

page.content<br /><br />b'\n\n \n A simple example page\n \n \n <p>Here is some simple content for this page.\n \n'</p>

BeautifulSoup 解析网页

下载好页面之后,使用 BeautifulSoup 解析页面内容,然后从 p 标签提取文本。导入库然后创建实例来解析网页:

from bs4 import BeautifulSoup<br />soup = BeautifulSoup(page.content, 'html.parser')

使用 prettify 属性可以将页面内容打印出来:

print(soup.prettify())<br /><br /><br /><br /> <br /> <br /> A simple example page<br /> <br /> <br /> <br /> <p><br /> Here is some simple content for this page.<br /> <br /> <br /></p>

因为所有标签都是嵌套的,我们可以一次移动一层。使用 soup 的 children 属性可以选择页面的所有顶层元素。

注意:children 返回的是生成器,需要调用 list 函数转换为列表。

list(soup.children)<br /><br />['html', '\n', <br /> <br /> A simple example page<br /> <br /> <br /> <p>Here is some simple content for this page.<br /> <br /> ]</p>

上述结果表明,页面顶层有两个标签: 和 标签。换行符 (\n) 也在列表中。下面看一下列表中每个元素的类型:

>> [type(item) for item in list(soup.children)] <br /><br />[bs4.element.Doctype, bs4.element.NavigableString, bs4.element.Tag]

每一项都是 BeautifulSoup 对象。 Dcotype 对象包含文档类型信息,NavigableString 呈现的是包含文档中的文本,Tag对象包含其它嵌套标签。最重要且经常用到的对象是 Tag 对象。

Tag 对象在HTML文档中起到导航作用,可以用来获取标签和文本。更多BeautifulSoup 对象看这里 [注2]。

通过 soup.children 获取 html 标签信息:

html = list(soup.children)[2]

children 属性返回的每一项都是 BeautifulSoup 对象,因此可以直接调用 children 方法。获取 html 标签的子标签信息:

list(html.children)<br /><br />['\n', <br /> A simple example page<br /> , '\n', <br /> <p>Here is some simple content for this page.<br /> , '\n']</p>

如上所示,有两个顶层标签: 和 。如果想要获取 title 和 p 标签对应的信息,需要先获取其所对应的父标签信息。比如,获取 p 标签信息,要先获取 标签信息:

body = list(html.children)[3]

因为 标签中只有 p 标签,所以可以很方便的获取 p 标签信息:

list(body.children)<br /><br />['\n', <p>Here is some simple content for this page., '\n']</p>

获取 p 标签信息:

p = list(body.children)[1]

获取 p 标签之后,使用 get_text 方法可以提取标签中的信息:

p.get_text()<br /><br />'Here is some simple content for this page.'

获取所有标签信息

上面所演示的内容对于了解页面导航信息非常有用,但是使用了很多命令来完成意见非常简单的任务。如果你想提取单个标签,可以使用 find_all 方法,可以获取页面中的所有标签实例:

soup = BeautifulSoup(page.content, 'html.parser')<br />soup.find_all('p')<br /><br />[<p>Here is some simple content for this page.]</p>

注意: find_all 返回的是列表,为了获取指定标签信息,需要循环或指定索引。

获取标签之后同样用 get_text 方法获取文本信息:

soup.find_all('p')[0].get_text()<br /><br />'Here is some simple content for this page.'

如果不想获取标签所有实例,可以使用 find 方法获取标签的第一个实例:

soup.find('p')<br /><br /><p>Here is some simple content for this page.</p>

利用 class 和 id 搜索标签

前面介绍了 class 和 id,但是还没有介绍它们的有用之处。class 和 id 是 CSS 所使用的,主要用来确定 HTML 元素应该使用什么类型。可以使用它们爬取特定元素。比如爬取下列网页时(URL:):

<br /> <br /> A simple example page<br /> <br /> <br /> <br /> <p span class="hljs-class" style="color: rgb(51, 51, 51); font-weight: 400; font-style: normal;"span class="hljs-keyword" style="color: rgb(51, 51, 51); font-weight: bold; font-style: normal;"class/span="span class="hljs-title" style="color: rgb(136, 0, 0); font-weight: bold; font-style: normal;"inner/span-span class="hljs-title" style="color: rgb(136, 0, 0); font-weight: bold; font-style: normal;"text/span span class="hljs-title" style="color: rgb(136, 0, 0); font-weight: bold; font-style: normal;"first/span-span class="hljs-title" style="color: rgb(136, 0, 0); font-weight: bold; font-style: normal;"item/span" span class="hljs-title" style="color: rgb(136, 0, 0); font-weight: bold; font-style: normal;"id/span="span class="hljs-title" style="color: rgb(136, 0, 0); font-weight: bold; font-style: normal;"first/span"><br /> First paragraph.<br /> <br /> <br /> Second paragraph.<br /> <br /> <br /> <br /> <br /> First outer paragraph.<br /> <br /> <br /> <br /> <br /> Second outer paragraph.<br /> <br /> <br /> <br />

创建 BeautifulSoup 对象:

page = requests.get("http://dataquestio.github.io/w ... 6quot;)<br />soup = BeautifulSoup(page.content, 'html.parser')<br />soup<br /><br /><br /><br />A simple example page<br /><br /><br /><br /><p span class="hljs-class" style="color: rgb(51, 51, 51); font-weight: 400; font-style: normal;"span class="hljs-keyword" style="color: rgb(51, 51, 51); font-weight: bold; font-style: normal;"class/span="span class="hljs-title" style="color: rgb(136, 0, 0); font-weight: bold; font-style: normal;"inner/span-span class="hljs-title" style="color: rgb(136, 0, 0); font-weight: bold; font-style: normal;"text/span span class="hljs-title" style="color: rgb(136, 0, 0); font-weight: bold; font-style: normal;"first/span-span class="hljs-title" style="color: rgb(136, 0, 0); font-weight: bold; font-style: normal;"item/span" span class="hljs-title" style="color: rgb(136, 0, 0); font-weight: bold; font-style: normal;"id/span="span class="hljs-title" style="color: rgb(136, 0, 0); font-weight: bold; font-style: normal;"first/span"><br /> First paragraph.<br /> <br /><br /> Second paragraph.<br /> <br /><br /><br /><br /> First outer paragraph.<br /> <br /><br /><br /><br /> Second outer paragraph.<br /> <br /><br /><br />

现在,使用 find_all 方法通过 class 和 id 搜索项。比如,搜索 class 值为 outer-text 的 p 标签:

soup.find_all('p', class_='outer-text')<br /><br />[<p span class="hljs-class" style="color: rgb(51, 51, 51); font-weight: 400; font-style: normal;"span class="hljs-keyword" style="color: rgb(51, 51, 51); font-weight: bold; font-style: normal;"class/span="span class="hljs-title" style="color: rgb(136, 0, 0); font-weight: bold; font-style: normal;"outer/span-span class="hljs-title" style="color: rgb(136, 0, 0); font-weight: bold; font-style: normal;"text/span span class="hljs-title" style="color: rgb(136, 0, 0); font-weight: bold; font-style: normal;"first/span-span class="hljs-title" style="color: rgb(136, 0, 0); font-weight: bold; font-style: normal;"item/span" span class="hljs-title" style="color: rgb(136, 0, 0); font-weight: bold; font-style: normal;"id/span="span class="hljs-title" style="color: rgb(136, 0, 0); font-weight: bold; font-style: normal;"second/span"><br /> <br /> First outer paragraph.<br /> <br /> , <br /> <br /> Second outer paragraph.<br /> <br /> ]

也可以搜索 class 值为 outer-text 的任何标签:

soup.find_all(class_="outer-text")<br /><br />[<p span class="hljs-class" style="color: rgb(51, 51, 51); font-weight: 400; font-style: normal;"span class="hljs-keyword" style="color: rgb(51, 51, 51); font-weight: bold; font-style: normal;"class/span="span class="hljs-title" style="color: rgb(136, 0, 0); font-weight: bold; font-style: normal;"outer/span-span class="hljs-title" style="color: rgb(136, 0, 0); font-weight: bold; font-style: normal;"text/span span class="hljs-title" style="color: rgb(136, 0, 0); font-weight: bold; font-style: normal;"first/span-span class="hljs-title" style="color: rgb(136, 0, 0); font-weight: bold; font-style: normal;"item/span" span class="hljs-title" style="color: rgb(136, 0, 0); font-weight: bold; font-style: normal;"id/span="span class="hljs-title" style="color: rgb(136, 0, 0); font-weight: bold; font-style: normal;"second/span"><br /> <br /> First outer paragraph.<br /> <br /> , <br /> <br /> Second outer paragraph.<br /> <br /> ]

当然也可以通过 id 搜索元素:

soup.find_all(id="first")<br /><br />[<p span class="hljs-class" style="color: rgb(51, 51, 51); font-weight: 400; font-style: normal;"span class="hljs-keyword" style="color: rgb(51, 51, 51); font-weight: bold; font-style: normal;"class/span="span class="hljs-title" style="color: rgb(136, 0, 0); font-weight: bold; font-style: normal;"inner/span-span class="hljs-title" style="color: rgb(136, 0, 0); font-weight: bold; font-style: normal;"text/span span class="hljs-title" style="color: rgb(136, 0, 0); font-weight: bold; font-style: normal;"first/span-span class="hljs-title" style="color: rgb(136, 0, 0); font-weight: bold; font-style: normal;"item/span" span class="hljs-title" style="color: rgb(136, 0, 0); font-weight: bold; font-style: normal;"id/span="span class="hljs-title" style="color: rgb(136, 0, 0); font-weight: bold; font-style: normal;"first/span"><br /> First paragraph.<br /> ]

CSS选择器

CSS选择器(用于确定HTML标签类型)同样可以用来搜索项。比如:

更多选择器在这里 [注3]。

BeautifulSoup 对象支持使用 select 方法通过选择器搜索页面。使用选择器获取 div 标签下的所有 p 标签:

soup.select("div p")<br /><br />[<p span class="hljs-class" style="color: rgb(51, 51, 51); font-weight: 400; font-style: normal;"span class="hljs-keyword" style="color: rgb(51, 51, 51); font-weight: bold; font-style: normal;"class/span="span class="hljs-title" style="color: rgb(136, 0, 0); font-weight: bold; font-style: normal;"inner/span-span class="hljs-title" style="color: rgb(136, 0, 0); font-weight: bold; font-style: normal;"text/span span class="hljs-title" style="color: rgb(136, 0, 0); font-weight: bold; font-style: normal;"first/span-span class="hljs-title" style="color: rgb(136, 0, 0); font-weight: bold; font-style: normal;"item/span" span class="hljs-title" style="color: rgb(136, 0, 0); font-weight: bold; font-style: normal;"id/span="span class="hljs-title" style="color: rgb(136, 0, 0); font-weight: bold; font-style: normal;"first/span"><br /> First paragraph.<br /> , <br /> Second paragraph.<br /> ]

注意: select 方法返回的时 BeautifulSoup 对象列表,就像 find 和 find_all 。

下载天气数据

目前,我们已经知道了提取网页信息的方法。下一步就是确定要爬取的网页。下面以爬取美国国家天气服务的天气信息为例:

网页显示了一周的天气预报信息,包括时间,温度以及一些描述信息。

了解网页结构

第一步,使用 Chrome 开发工具查看网页布局,使用其它浏览器也可以。

按F12即可打开开发者工具,即下图中红色框部分。

Elements 部分包含了网页中的所有标签,通过标签你可以确定页面的布局。

右击页面中 Extended Forecast所对应的网页部分(下图中红色框部分),然后选择 "Inspect"(检查),然后就会定位到 Elements 中的标签(黄色阴影部分的父标签)。

然后就能获取到所有的预测数据,在此例中对应的是 id 为 seven-day-forecast 的

标签。

打开

标签的内容就可以发现每一天的预测数据:日期,温度,简要描述。下图中绿色框和红色框分别对应的是一天的预测(包含在 class 为 tombstone-container 的

标签内)。

现在已经知道如何下载网页并解析网页了,下面我们开始实战:

page = requests.get("http://forecast.weather.gov/Ma ... 6quot;)<br />soup = BeautifulSoup(page.content, 'html.parser')<br />seven_day = soup.find(id="seven-day-forecast")<br />forecast_items = seven_day.find_all(class_="tombstone-container")<br />tonight = forecast_items[0]<br />print(tonight.prettify())<br /><br /><br /> <br /> Tonight<br /> <br /> <br /> <br /> <br /> <br /> <br /> <br />

<br /> Mostly Clear<br /> <br />

<br /> Low: 49 °F<br /> <br /></p>

提取页面信息

单标签信息提取

预测项 tonight 中包含了我们所需要的所有信息,其中包含了四项:

提取预测项名称,简要描述及温度:

period = tonight.find(class_="period-name").get_text()<br />short_desc = tonight.find(class_="short-desc").get_text()<br />temp = tonight.find(class_="temp").get_text()<br /><br />print(period)<br />print(short_desc)<br />print(temp)<br /><br />Tonight<br />Mostly Clear<br />Low: 49 °F

现在,从 img 标签中提取 title 属性。将 BeautifulSoup 对象视作字典,传递需要的属性作为键:

img = tonight.find("img")<br />desc = img['title']<br /><br />print(desc)<br /><br />Tonight: Mostly clear, with a low around 49. West northwest wind 12 to 17 mph decreasing to 6 to 11 mph after midnight. Winds could gust as high as 23 mph.

提取所有信息

上面介绍了如何提起单标签信息,下面介绍如何利用CSS选择器和列表解析,一次提取所有信息:

period_tags = seven_day.select(".tombstone-container .period-name")<br />periods = [pt.get_text() for pt in period_tags]<br />periods<br /><br />['Tonight',<br /> 'Thursday',<br /> 'ThursdayNight',<br /> 'Friday',<br /> 'FridayNight',<br /> 'Saturday',<br /> 'SaturdayNight',<br /> 'Sunday',<br /> 'SundayNight']

按照上面的方式获取了有序的时间名称,现在获取另外3个字段:

short_descs = [sd.get_text() for sd in seven_day.select(".tombstone-container .short-desc")]<br />temps = [t.get_text() for t in seven_day.select(".tombstone-container .temp")]<br />descs = [d["title"] for d in seven_day.select(".tombstone-container img")]<br /><br />print(short_descs)<br />print(temps)<br />print(descs)<br /><br />['Mostly Clear', 'Sunny', 'Mostly Clear', 'Sunny', 'Slight ChanceRain', 'Rain Likely', 'Rain Likely', 'Rain Likely', 'Chance Rain']<br />['Low: 49 °F', 'High: 63 °F', 'Low: 50 °F', 'High: 67 °F', 'Low: 57 °F', 'High: 64 °F', 'Low: 57 °F', 'High: 64 °F', 'Low: 55 °F']<br />['Tonight: Mostly clear, with a low around 49. West northwest wind 12 to 17 mph decreasing to 6 to 11 mph after midnight. Winds could gust as high as 23 mph. ', 'Thursday: Sunny, with a high near 63. North wind 3 to 5 mph. ', 'Thursday Night: Mostly clear, with a low around 50. Light and variable wind becoming east southeast 5 to 8 mph after midnight. ', 'Friday: Sunny, with a high near 67. Southeast wind around 9 mph. ', 'Friday Night: A 20 percent chance of rain after 11pm. Partly cloudy, with a low around 57. South southeast wind 13 to 15 mph, with gusts as high as 20 mph. New precipitation amounts of less than a tenth of an inch possible. ', 'Saturday: Rain likely. Cloudy, with a high near 64. Chance of precipitation is 70%. New precipitation amounts between a quarter and half of an inch possible. ', 'Saturday Night: Rain likely. Cloudy, with a low around 57. Chance of precipitation is 60%.', 'Sunday: Rain likely. Cloudy, with a high near 64.', 'Sunday Night: A chance of rain. Mostly cloudy, with a low around 55.']

存储数据到 DataFrame

下面将数据存储到 pandas 的 DataFrame 中并分析之。DataFrame 可以存储表型数据并很容易的进行数据分析。

将上述信息传递给 DataFrame 类,字典中的键表示列名,键值表示每一列的值:

import pandas as pd<br />weather = pd.DataFrame({<br /> "period": periods, <br /> "short_desc": short_descs, <br /> "temp": temps, <br /> "desc":descs<br /> })<br />weather<br /><br /> desc period short_desc temp<br />0 Tonight: Mostly clear, with a low around 49. W... Tonight Mostly Clear Low: 49 °F<br />1 Thursday: Sunny, with a high near 63. North wi... Thursday Sunny High: 63 °F<br />2 Thursday Night: Mostly clear, with a low aroun... ThursdayNight Mostly Clear Low: 50 °F<br />3 Friday: Sunny, with a high near 67. Southeast ... Friday Sunny High: 67 °F<br />4 Friday Night: A 20 percent chance of rain afte... FridayNight Slight ChanceRain Low: 57 °F<br />5 Saturday: Rain likely. Cloudy, with a high ne... Saturday Rain Likely High: 64 °F<br />6 Saturday Night: Rain likely. Cloudy, with a l... SaturdayNight Rain Likely Low: 57 °F<br />7 Sunday: Rain likely. Cloudy, with a high near... Sunday Rain Likely High: 64 °F<br />8 Sunday Night: A chance of rain. Mostly cloudy... SundayNight Chance Rain Low: 55 °F

现在,我们可以对数据进行简单的分析。比如利用正则表达式和 Series.str.extract 方法获取温度的数值:

temp_nums = weather["temp"].str.extract("(?P\d+)", expand=False)<br />weather["temp_num"] = temp_nums.astype('int')<br />temp_nums<br /><br />0 49<br />1 63<br />2 50<br />3 67<br />4 57<br />5 64<br />6 57<br />7 64<br />8 55<br />Name: temp_num, dtype: object

然后计算温度的平均值:

weather["temp_num"].mean()<br /><br />58.444444444444443

如果某天晚上你要出去,可以查看晚上的天气信息:

is_night = weather["temp"].str.contains("Low")<br />weather["is_night"] = is_night<br />is_night<br /><br />0 True<br />1 False<br />2 True<br />3 False<br />4 True<br />5 False<br />6 True<br />7 False<br />8 True<br />Name: temp, dtype: bool<br /><br />weather[is_night]

下一步

现在你已经了解了如何爬取网页并提取数据。下一步就是选择一个网站然后继续练习。

Just do it!

注1:

注2:#kinds-of-objects

注3:

预览时标签不可点

收录于合集 #

个

推广 | Python数据分析脱坑指南,正确的“入门之路”该如何开启?

网站优化 • 优采云 发表了文章 • 0 个评论 • 135 次浏览 • 2022-05-25 08:40

注:本文来自 EmTech China 全球新兴科技峰会合作媒体 DT 财经(ID:DTdatahero)

在 DT 君的社群中,但凡一提起 Python,大家的兴趣就空前高涨。不管出发点是兴趣驱动、拓展思维,还是工作需要、想要转行,“学习 Python”这件事儿早已被大家提上了日程。

相信连很多还没入行的小白都知道,对于毫无编程经验的人来说,通过学习 Python 跨入数据分析的大门,是一条相对高效的路径。

为啥?原因有很多,比如:

相比于其他语言,Python 具有很高的可读性,语法简单易懂,对新手友好到炸裂;丰富的第三方模块,再也不用自己从头开始造轮子;开发环境也是简单到哭泣......

但是,真正开始上手学习的同学,会发现即便是这门极易 Pick 的编程语言,也是一坑接一坑。

DT 君之前也收到过不少大家学习时的吐槽:

针对大家的苦恼,DT 君联合纽约数据科学学院(NYC Data Science Academy) 发起了“”(报名方式详见文末),希望通过 45 个小时左右的线上跟学教程,配合专业导师答疑指导,带大家扎实地掌握 Python 基础知识,并通过大量实操案例,让大家掌握如何独立编写 Python 程序进行数据读取,最终完成完整的数据分析和可视化项目。

▍训练营大纲(可滑动)

第一部分 Python编程入门

本训练营将介绍 Python 基本数据结构,条件判断和循环、函数、面向对象编程,以及常见的 Linux 操作指令。 训练营围绕多个迷你项目,学员通过每个项目学习重要概念、练习编程能力,这门课将为你的技术职业发展打下扎实的编程基础。

Unit 1:初识 linux 操作系统

Unit 2:感受 Python 之美

Unit 3:Python 中的基础数据结构

Unit 4:让我们聊聊进阶版的 Python

第二部分 网络爬虫项目实战

本训练营将教授如何用 Python 抓取网络数据。训练营从爬虫技术的基本原理和技术框架开始,围绕多个实战项目,分别介绍三个功能强大、及其实用的爬虫技术包 - BeautifulSoup,Scrapy,Selenium。

完成学习后,学员可以自己编写爬虫脚本,搭建自动网络抓取程序,完成数据抓取、清理、存储、并进行初步数据分析的全过程。

Unit 1:初识网络爬虫 (Beautifulsoup)

Unit 2:初识 Scrapy package

Unit 3:Scrapy 项目实战

第三部分 数据分析和可视化

本训练营将介绍数据领域内最优秀的编程模块,包括科学计算常用的 numpy 和 scipy 包,专业处理和分析二维数据的 pandas 包,数据可视化 matplotlib 和 seaborn 包。学员将学习数据清理,探索数据中的模式和规律,处理缺失数据,转化、合并和重塑数据集,建立数据可视化模型。学习后期,学生会完成一个完整的数据分析和可视化项目。

Unit 1:Numpy & Scipy 包

Unit 2:Pandas 数据分析

Unit 3:Matplotlib & Seaborn 数据可视化

如果这样讲完你对“”还没有完整认知,也不知道学完之后能达到怎样的水平,能完成怎样的数据分析项目?那么下面这些以往学生作品可以帮助你更好地了解:

1.用数据分析一个商业潮流,寻找那些成功商业案例中的隐藏规律:

《大数据呈现的“椰子鞋”转卖江湖》

过去十年的科技发展,让潮鞋(Sneakers)在各类社交媒体平台上获得更多曝光,转卖潮鞋生意已经迅速成长为一个价值10亿美元的产业。那么,潮鞋转卖市场到底是什么样子?

这位学员选择了阿迪达斯的网红款“椰子鞋”(Adidas Yeezy Sneakers)作为研究对象,使用了 Scrapy 和 Selenium 对最著名的潮鞋转售网站 进行数据爬取,获得了椰子鞋的历史销售数据,并对“椰子鞋”的二手市场、倒卖价格趋势做出了分析。

2.从数据的视角观察一个社会现象,让你在生活中的选择更加“有据可循”:

《星巴克铁粉必备:你的收集欲,数据来买单!》

有这么一群人,他们是星巴克马克杯的狂热爱好者,自称为“muggers”,活跃在Facebook,eBay 和其他在线社交平台,积极地从世界各地的其他收藏者手里交换或购买自己想要的星巴克马克杯。

这位学员个人也是个杯子控,并且对和她有相同爱好的人们感到好奇。他们都在哪儿?藏品数量是多少?现在最in的是哪一款?

于是她爬取了 (最大的星巴克爱好者社区在线平台之一),运用 K-means 聚类算法(非监督学习算法),对全世界的星巴克爱好者们进行研究,并对杯子稀有程度及供需关系做出了可视化呈现。

3.用数据去分析一个体育项目,明白场上那些历史级的运动表现不仅是运动员的功劳,更是科学训练的结果。

《如何才能像勇士队一样科学地扔三分球?》

这三年,库里和他的金州勇士队让整个 NBA 都刮起三分雨。几乎所有的球队都开始围绕三分球布置战术,甚至连高大的中锋们都不得不跑出去扔起了三分球。“小球”风格被公认成为了这个时代的 NBA 主流。

但三分球对 NBA 球队究竟有多重要?它是否真的能神奇地改变比赛走向?这位学员通过爬取 NBA 官方网站和 Nbaminer 网站上官方统计数据和投篮距离数据,将两组数据表按照“赛季”和“球队名称”进行了对应整合、清理,得出了 NBA 强队和三分球之间的微妙联系。

他还引入了一个较复杂的概念——“进攻评分”(Offence Rating),去分析三分球和其它得分球之间的进攻优势。

还有很多很多.......

由于篇幅有限,DT 君只能有限截取作品片段,感兴趣的朋友可以戳作品图片展开阅读。也可以复制下方链接到浏览器,在纽约数据科学学院官网的学生作品页面,浏览英文原文。( 注意科学上网)

学习 Python 不仅仅是掌握了一门编程语言,更关键的是懂得如何运用数据解决生活中的实际问题。养成数据思维,学会运用严谨的分析方法,你便可以通过有理有据的结论,培养自己独到的洞察力。

如果你即将面临就业或正在面临职业转型,这次的 Python 训练营将从 0 到 1为你打下编程基础,通过对数据获取、清理、转化、合并,重塑数据集,建立数据可视化模型等各项环节的项目实践,带你养成初级数据分析师的必备技能。

掌握 Python 数据分析并非一朝一夕就可以速成的易事,但有了高效的入门方法、专业导师的引航指路、训练营成员的陪伴学习,相信可以帮助你快速脱坑入门,重拾学习乐趣。

▍Python 训练营限时抢购中!100 个有限名额先到先得!

训练营原价为 2999 元,现在可参与两种折扣福利:

限时抢购价格:2399 元 (点击“阅读原文”,可去课程官网直接购买)

限时团购价格:2199 元(扫下方“二维码”,在小鹅通平台支付,享受“二人成团”最低折扣)

备注:

无论你是已经完成付款希望加入训练营社群参与学习,或是想要加入社群寻找“拼友”享受最低折扣优惠,都可加万能的DT君微信(dtcaijing004),并备注“训练营”。DT 君稍后会拉你进入相应社群~

DT 财经和 CBNData 均属于第一财经数据科技有限公司,本次训练营由 DT 财经数据侠主办,CBNData 官网全程支持。 查看全部

推广 | Python数据分析脱坑指南,正确的“入门之路”该如何开启?

注:本文来自 EmTech China 全球新兴科技峰会合作媒体 DT 财经(ID:DTdatahero)

在 DT 君的社群中,但凡一提起 Python,大家的兴趣就空前高涨。不管出发点是兴趣驱动、拓展思维,还是工作需要、想要转行,“学习 Python”这件事儿早已被大家提上了日程。

相信连很多还没入行的小白都知道,对于毫无编程经验的人来说,通过学习 Python 跨入数据分析的大门,是一条相对高效的路径。

为啥?原因有很多,比如:

相比于其他语言,Python 具有很高的可读性,语法简单易懂,对新手友好到炸裂;丰富的第三方模块,再也不用自己从头开始造轮子;开发环境也是简单到哭泣......

但是,真正开始上手学习的同学,会发现即便是这门极易 Pick 的编程语言,也是一坑接一坑。

DT 君之前也收到过不少大家学习时的吐槽:

针对大家的苦恼,DT 君联合纽约数据科学学院(NYC Data Science Academy) 发起了“”(报名方式详见文末),希望通过 45 个小时左右的线上跟学教程,配合专业导师答疑指导,带大家扎实地掌握 Python 基础知识,并通过大量实操案例,让大家掌握如何独立编写 Python 程序进行数据读取,最终完成完整的数据分析和可视化项目。

▍训练营大纲(可滑动)

第一部分 Python编程入门

本训练营将介绍 Python 基本数据结构,条件判断和循环、函数、面向对象编程,以及常见的 Linux 操作指令。 训练营围绕多个迷你项目,学员通过每个项目学习重要概念、练习编程能力,这门课将为你的技术职业发展打下扎实的编程基础。

Unit 1:初识 linux 操作系统

Unit 2:感受 Python 之美

Unit 3:Python 中的基础数据结构

Unit 4:让我们聊聊进阶版的 Python

第二部分 网络爬虫项目实战

本训练营将教授如何用 Python 抓取网络数据。训练营从爬虫技术的基本原理和技术框架开始,围绕多个实战项目,分别介绍三个功能强大、及其实用的爬虫技术包 - BeautifulSoup,Scrapy,Selenium。

完成学习后,学员可以自己编写爬虫脚本,搭建自动网络抓取程序,完成数据抓取、清理、存储、并进行初步数据分析的全过程。

Unit 1:初识网络爬虫 (Beautifulsoup)

Unit 2:初识 Scrapy package

Unit 3:Scrapy 项目实战

第三部分 数据分析和可视化

本训练营将介绍数据领域内最优秀的编程模块,包括科学计算常用的 numpy 和 scipy 包,专业处理和分析二维数据的 pandas 包,数据可视化 matplotlib 和 seaborn 包。学员将学习数据清理,探索数据中的模式和规律,处理缺失数据,转化、合并和重塑数据集,建立数据可视化模型。学习后期,学生会完成一个完整的数据分析和可视化项目。

Unit 1:Numpy & Scipy 包

Unit 2:Pandas 数据分析

Unit 3:Matplotlib & Seaborn 数据可视化

如果这样讲完你对“”还没有完整认知,也不知道学完之后能达到怎样的水平,能完成怎样的数据分析项目?那么下面这些以往学生作品可以帮助你更好地了解:

1.用数据分析一个商业潮流,寻找那些成功商业案例中的隐藏规律:

《大数据呈现的“椰子鞋”转卖江湖》

过去十年的科技发展,让潮鞋(Sneakers)在各类社交媒体平台上获得更多曝光,转卖潮鞋生意已经迅速成长为一个价值10亿美元的产业。那么,潮鞋转卖市场到底是什么样子?

这位学员选择了阿迪达斯的网红款“椰子鞋”(Adidas Yeezy Sneakers)作为研究对象,使用了 Scrapy 和 Selenium 对最著名的潮鞋转售网站 进行数据爬取,获得了椰子鞋的历史销售数据,并对“椰子鞋”的二手市场、倒卖价格趋势做出了分析。

2.从数据的视角观察一个社会现象,让你在生活中的选择更加“有据可循”:

《星巴克铁粉必备:你的收集欲,数据来买单!》

有这么一群人,他们是星巴克马克杯的狂热爱好者,自称为“muggers”,活跃在Facebook,eBay 和其他在线社交平台,积极地从世界各地的其他收藏者手里交换或购买自己想要的星巴克马克杯。

这位学员个人也是个杯子控,并且对和她有相同爱好的人们感到好奇。他们都在哪儿?藏品数量是多少?现在最in的是哪一款?

于是她爬取了 (最大的星巴克爱好者社区在线平台之一),运用 K-means 聚类算法(非监督学习算法),对全世界的星巴克爱好者们进行研究,并对杯子稀有程度及供需关系做出了可视化呈现。

3.用数据去分析一个体育项目,明白场上那些历史级的运动表现不仅是运动员的功劳,更是科学训练的结果。

《如何才能像勇士队一样科学地扔三分球?》

这三年,库里和他的金州勇士队让整个 NBA 都刮起三分雨。几乎所有的球队都开始围绕三分球布置战术,甚至连高大的中锋们都不得不跑出去扔起了三分球。“小球”风格被公认成为了这个时代的 NBA 主流。

但三分球对 NBA 球队究竟有多重要?它是否真的能神奇地改变比赛走向?这位学员通过爬取 NBA 官方网站和 Nbaminer 网站上官方统计数据和投篮距离数据,将两组数据表按照“赛季”和“球队名称”进行了对应整合、清理,得出了 NBA 强队和三分球之间的微妙联系。

他还引入了一个较复杂的概念——“进攻评分”(Offence Rating),去分析三分球和其它得分球之间的进攻优势。

还有很多很多.......

由于篇幅有限,DT 君只能有限截取作品片段,感兴趣的朋友可以戳作品图片展开阅读。也可以复制下方链接到浏览器,在纽约数据科学学院官网的学生作品页面,浏览英文原文。( 注意科学上网)

学习 Python 不仅仅是掌握了一门编程语言,更关键的是懂得如何运用数据解决生活中的实际问题。养成数据思维,学会运用严谨的分析方法,你便可以通过有理有据的结论,培养自己独到的洞察力。

如果你即将面临就业或正在面临职业转型,这次的 Python 训练营将从 0 到 1为你打下编程基础,通过对数据获取、清理、转化、合并,重塑数据集,建立数据可视化模型等各项环节的项目实践,带你养成初级数据分析师的必备技能。

掌握 Python 数据分析并非一朝一夕就可以速成的易事,但有了高效的入门方法、专业导师的引航指路、训练营成员的陪伴学习,相信可以帮助你快速脱坑入门,重拾学习乐趣。

▍Python 训练营限时抢购中!100 个有限名额先到先得!

训练营原价为 2999 元,现在可参与两种折扣福利:

限时抢购价格:2399 元 (点击“阅读原文”,可去课程官网直接购买)

限时团购价格:2199 元(扫下方“二维码”,在小鹅通平台支付,享受“二人成团”最低折扣)

备注:

无论你是已经完成付款希望加入训练营社群参与学习,或是想要加入社群寻找“拼友”享受最低折扣优惠,都可加万能的DT君微信(dtcaijing004),并备注“训练营”。DT 君稍后会拉你进入相应社群~

DT 财经和 CBNData 均属于第一财经数据科技有限公司,本次训练营由 DT 财经数据侠主办,CBNData 官网全程支持。

如何利用Python网络爬虫抓取微信好友数量以及微信好友的男女比例

网站优化 • 优采云 发表了文章 • 0 个评论 • 189 次浏览 • 2022-05-22 22:33

点击上方“Python爬虫与数据挖掘”,进行关注

回复“书籍”即可获赠Python从入门到进阶共10本电子书

前几天给大家分享了利用Python网络爬虫抓取微信朋友圈的动态(上)和利用Python网络爬虫爬取微信朋友圈动态——附代码(下),并且对抓取到的数据进行了Python词云和wordart可视化,感兴趣的伙伴可以戳这篇文章:利用Python词云和wordart可视化工具对朋友圈数据进行可视化。

今天我们继续focus on微信,不过这次给大家带来的是利用Python网络爬虫抓取微信好友总数量和微信好友男女性别的分布情况。代码实现蛮简单的,具体的教程如下。小伙伴们,文章最后有彩蛋喔~~

相信大家都知道,直接通过网页抓取微信的数据不太可行,但是强大的Python提供了一个itchat库,搭建了链接微信好友信息的友好桥梁,直接上代码,如下图所示。

关键部分的代码,都有注释,方便大家理解。当程序运行的时候,会弹出一个微信二维码,此时需要用手机扫码授权登录。如果您当时正在微信电脑版上登录的话,此时微信会强制退出,然后进行授权。授权成功之后,程序会继续往下执行,稍等片刻之后,便可以给您返回您的微信好友数量信息。

在这里,以小编的微信好友为例,程序运行之后,得到的信息如下图所示:

可以看到,小编的微信好友共有1637人。相信很多小伙伴已经知道在手机微信页面的第二个选项卡“通讯录”下,一直往下拉取好友列表,直到最后,就可以看到自己微信好友的数量,大家可以试试看,是不是和Python程序抓取到的数量是否一致。

接下来,小编继续带您继续发现微信好友中的男女比例。其实也很简单,代码实现也很容易,这里介绍两种方式,如下图所示。(注:代码是接着前面的程序往下继续写的)

可以自定义一个函数,获取性别信息,也可以直接调用value_counts()方法,可以更方便统计各项出现的次数。小编的微信好友男女数量情况如下图所示,在这里,1代表男士,2代表女士,0代表未知性别(因为有的好友并没有设置性别这一项)。