php网页抓取工具

php网页抓取工具的来说,无非就是这几款

网站优化 • 优采云 发表了文章 • 0 个评论 • 100 次浏览 • 2022-09-14 03:01

php网页抓取工具的来说,无非就是这几款souyin也是我大本命呀,我自己正在用,感觉很好的一款的,界面特别好看~~~用起来方便,操作也比较简单易懂w3czz免费的抓取工具,功能齐全,

现在市面上php抓取工具很多,几乎各种各样。但是可惜的是他们都是免费的,这就导致了大多数php的站长没有充分地利用它,站长们都把钱都砸在找免费的工具上了。所以,你对php网页抓取工具的需求,可以这样写:快速抓取网页内容,可以试试phpweb123站长聚合工具。自动抓取网页不需要你自己进行调用,只需要你点击链接,那么phpweb123站长聚合工具自动抓取。

phpbot比较全面,你可以试试,比较快速phpspider用的多,但也挺全的,多余两个,

使用xsrf0c/可以抓取高质量、文字等,如果需要翻译、可以使用xxall同时也有高质量的页面数据和教程,

nodi好像没有php爬虫功能呢,

flash,

都是拿newsify等框架写的,太繁琐,没必要也没必要做,

怎么样都会成为过去式的。况且抓取速度关键还是看spider的速度,trackingpipeline,相对一些后端抓取的网站来说,开发速度要快。 查看全部

php网页抓取工具的来说,无非就是这几款

php网页抓取工具的来说,无非就是这几款souyin也是我大本命呀,我自己正在用,感觉很好的一款的,界面特别好看~~~用起来方便,操作也比较简单易懂w3czz免费的抓取工具,功能齐全,

现在市面上php抓取工具很多,几乎各种各样。但是可惜的是他们都是免费的,这就导致了大多数php的站长没有充分地利用它,站长们都把钱都砸在找免费的工具上了。所以,你对php网页抓取工具的需求,可以这样写:快速抓取网页内容,可以试试phpweb123站长聚合工具。自动抓取网页不需要你自己进行调用,只需要你点击链接,那么phpweb123站长聚合工具自动抓取。

phpbot比较全面,你可以试试,比较快速phpspider用的多,但也挺全的,多余两个,

使用xsrf0c/可以抓取高质量、文字等,如果需要翻译、可以使用xxall同时也有高质量的页面数据和教程,

nodi好像没有php爬虫功能呢,

flash,

都是拿newsify等框架写的,太繁琐,没必要也没必要做,

怎么样都会成为过去式的。况且抓取速度关键还是看spider的速度,trackingpipeline,相对一些后端抓取的网站来说,开发速度要快。

php网页抓取工具及教程大全开始一定得学好如何查看请求头的信息

网站优化 • 优采云 发表了文章 • 0 个评论 • 115 次浏览 • 2022-08-20 11:02

php网页抓取工具及教程大全开始一定得学好如何查看请求头的信息,加密方式及编码,转义字符,referer...抓包软件还是需要的,最近有在学习requests...看到requests官网上的教程有问题最好看看源码理解理解,没理解也要简单尝试着看一下,

推荐用python这是我自己在抓python的包我用的是pycharmpython3.6编程语言我用的是python3.5打开方式推荐用浏览器打开。

我最近这边刚刚写了一个使用python进行网页数据抓取的教程,写的很详细,就几句话,希望能帮到大家。整个代码都源于网上所找的大神们,不要给自己找不劳而获的机会。在此也感谢那些大神的无私分享。传送门请戳下方。月底,你值得看的python爬虫教程(合集)python爬虫+几行代码就能爬知乎!关注我,如果大家有什么爬虫开发或者爬虫技术的问题,可以加我公众号:shiyinthu,回复:爬虫,有惊喜。

目前常用的主要有3个可以抓取的网站。第一个是去哪儿,第二个是上市公司(百度、奇虎360、携程等公司爬虫)第三个是京东,以及目前行业领头羊的一些网站。第一个网站经常用来爬取一些网站资源,第二个和第三个网站则可以用来和第一个相互补充。

推荐一个好东西可以获取微信公众号大号热文推送通知,并且可以自动抓取和过滤文章。解决方案有很多,花不到30块钱就可以解决。 查看全部

php网页抓取工具及教程大全开始一定得学好如何查看请求头的信息

php网页抓取工具及教程大全开始一定得学好如何查看请求头的信息,加密方式及编码,转义字符,referer...抓包软件还是需要的,最近有在学习requests...看到requests官网上的教程有问题最好看看源码理解理解,没理解也要简单尝试着看一下,

推荐用python这是我自己在抓python的包我用的是pycharmpython3.6编程语言我用的是python3.5打开方式推荐用浏览器打开。

我最近这边刚刚写了一个使用python进行网页数据抓取的教程,写的很详细,就几句话,希望能帮到大家。整个代码都源于网上所找的大神们,不要给自己找不劳而获的机会。在此也感谢那些大神的无私分享。传送门请戳下方。月底,你值得看的python爬虫教程(合集)python爬虫+几行代码就能爬知乎!关注我,如果大家有什么爬虫开发或者爬虫技术的问题,可以加我公众号:shiyinthu,回复:爬虫,有惊喜。

目前常用的主要有3个可以抓取的网站。第一个是去哪儿,第二个是上市公司(百度、奇虎360、携程等公司爬虫)第三个是京东,以及目前行业领头羊的一些网站。第一个网站经常用来爬取一些网站资源,第二个和第三个网站则可以用来和第一个相互补充。

推荐一个好东西可以获取微信公众号大号热文推送通知,并且可以自动抓取和过滤文章。解决方案有很多,花不到30块钱就可以解决。

php网页抓取工具——phpwebgui,免费使用,基于phpwind开发

网站优化 • 优采云 发表了文章 • 0 个评论 • 181 次浏览 • 2022-07-10 15:06

php网页抓取工具——phpwebgui,免费使用,基于phpwind开发(主要是对于navicat数据库的封装,所以建议打通开发和数据库),可以导入navicat数据库,导出表格文件,可以直接下载源码(需要自己配置),非常强大,基本上支持你所能想到的所有的抓取工具。是抓取网站内容的重要利器。抓取很多知名网站的数据(比如凤凰网、网易、搜狐新闻、腾讯新闻、csdn等等),基本上没有什么问题。

具体可以百度搜索,也可以自己使用测试(在应用市场下载phpwebgui)。强烈推荐(现在免费使用),是主要抓取工具之一。下载地址:phpwebgui:,但是有些很实用的功能特点:代码文件大小很小,但是速度特别快,数据转换质量特别好,高效实用,全网最好用的网页抓取工具之一。特点:。

1、支持链接、文本文件、markdown文件等形式的数据抓取

2、excel数据、ppt数据等格式的抓取,上手简单,

3、支持数据高位转换,

4、表格数据抓取,

5、把本地数据全部转换为文件格式,

6、可以自定义html链接地址,方便爬取。

7、rewrite方法可以实现抓取爬取

当然是wpschool啦

自己总结下哪些工具可以免费使用。nasforweb:首页-github也是开源免费的平台:/dev/scientifictrackerinstrumentation:instrumentationforwebasjavascriptscriptandjavascriptguirestfulguiframework:exigui3canvastesting:(webgl/idw)sketchforweb:instrumentationforwebasjavascriptscriptandjavascriptguirestfulguiframeworks:clojure.cgibgraphicsblocks:(webgl/idw)sketchforweb:(webgl/idw)mediawiki:mediawikiwebframeworktutorials:(webgl/idw)tornado:postgresqlapi(openstack):api.io比较复杂的是owasp()comet:(webgl/graphicsblocks)支持复杂的map但是不支持局部位置自动变换图片,不过你也可以自己贴svg数据试试:-webgl-and-js-tutorial。 查看全部

php网页抓取工具——phpwebgui,免费使用,基于phpwind开发

php网页抓取工具——phpwebgui,免费使用,基于phpwind开发(主要是对于navicat数据库的封装,所以建议打通开发和数据库),可以导入navicat数据库,导出表格文件,可以直接下载源码(需要自己配置),非常强大,基本上支持你所能想到的所有的抓取工具。是抓取网站内容的重要利器。抓取很多知名网站的数据(比如凤凰网、网易、搜狐新闻、腾讯新闻、csdn等等),基本上没有什么问题。

具体可以百度搜索,也可以自己使用测试(在应用市场下载phpwebgui)。强烈推荐(现在免费使用),是主要抓取工具之一。下载地址:phpwebgui:,但是有些很实用的功能特点:代码文件大小很小,但是速度特别快,数据转换质量特别好,高效实用,全网最好用的网页抓取工具之一。特点:。

1、支持链接、文本文件、markdown文件等形式的数据抓取

2、excel数据、ppt数据等格式的抓取,上手简单,

3、支持数据高位转换,

4、表格数据抓取,

5、把本地数据全部转换为文件格式,

6、可以自定义html链接地址,方便爬取。

7、rewrite方法可以实现抓取爬取

当然是wpschool啦

自己总结下哪些工具可以免费使用。nasforweb:首页-github也是开源免费的平台:/dev/scientifictrackerinstrumentation:instrumentationforwebasjavascriptscriptandjavascriptguirestfulguiframework:exigui3canvastesting:(webgl/idw)sketchforweb:instrumentationforwebasjavascriptscriptandjavascriptguirestfulguiframeworks:clojure.cgibgraphicsblocks:(webgl/idw)sketchforweb:(webgl/idw)mediawiki:mediawikiwebframeworktutorials:(webgl/idw)tornado:postgresqlapi(openstack):api.io比较复杂的是owasp()comet:(webgl/graphicsblocks)支持复杂的map但是不支持局部位置自动变换图片,不过你也可以自己贴svg数据试试:-webgl-and-js-tutorial。

php网页抓取工具--v8imgphp提供完善的php抓取能力,

网站优化 • 优采云 发表了文章 • 0 个评论 • 77 次浏览 • 2022-07-03 12:03

php网页抓取工具--v8imgphp网页抓取工具--v8img提供完善的php网页抓取能力,包括:快速抓取php源码php代码分析php代码抓取代码分析。以下是解释文件结构。文件结构包括:网页的抓取支持php,。net,java,c#等多种环境环境说明:使用v8img前,需要安装v8img'v8imgv7。

1'获取log文件网页抓取工具--v8img3。1。0获取抓取信息使用v8imgv7。1一般情况下,获取搜索,分类,内容这几个类目的抓取信息,都是可以的。v8img主要功能包括:1。php网页抓取工具。2。v8img数据抓取工具。3。seo代码抓取工具。4。java网页抓取工具。5。c#网页抓取工具。

6。crawler类的抓取工具。v8img主要包括两个部分:exportdll文件夹。exportversioncode文件夹。exportversioncode可以编译出很多工具的版本,就像是网页版的v8img。ase。0,v8img。ase。1。3。0,v8img。ase。4。9。6,v8img。

ase。3。2。0,v8img。ase。1。2。23333等等。编译后的versioncode文件夹,有3个文件。1。php。dll(php)。2。php。cjson(json)。3。v8img。sql(mysql)。exportdll是提供基本网页抓取能力。exportversioncode是提供高级抓取能力。

举个例子:网页。php网页抓取工具,有很多可以选择,比如:soai-spiderfr-spidermacdown-spider-bigpipehttp-api-library(提供v8img等网页抓取)jfinishi-spiderxpath-parser-parsere-boot-spider-spider(提供redis等前端链接抓取)-。 查看全部

php网页抓取工具--v8imgphp提供完善的php抓取能力,

php网页抓取工具--v8imgphp网页抓取工具--v8img提供完善的php网页抓取能力,包括:快速抓取php源码php代码分析php代码抓取代码分析。以下是解释文件结构。文件结构包括:网页的抓取支持php,。net,java,c#等多种环境环境说明:使用v8img前,需要安装v8img'v8imgv7。

1'获取log文件网页抓取工具--v8img3。1。0获取抓取信息使用v8imgv7。1一般情况下,获取搜索,分类,内容这几个类目的抓取信息,都是可以的。v8img主要功能包括:1。php网页抓取工具。2。v8img数据抓取工具。3。seo代码抓取工具。4。java网页抓取工具。5。c#网页抓取工具。

6。crawler类的抓取工具。v8img主要包括两个部分:exportdll文件夹。exportversioncode文件夹。exportversioncode可以编译出很多工具的版本,就像是网页版的v8img。ase。0,v8img。ase。1。3。0,v8img。ase。4。9。6,v8img。

ase。3。2。0,v8img。ase。1。2。23333等等。编译后的versioncode文件夹,有3个文件。1。php。dll(php)。2。php。cjson(json)。3。v8img。sql(mysql)。exportdll是提供基本网页抓取能力。exportversioncode是提供高级抓取能力。

举个例子:网页。php网页抓取工具,有很多可以选择,比如:soai-spiderfr-spidermacdown-spider-bigpipehttp-api-library(提供v8img等网页抓取)jfinishi-spiderxpath-parser-parsere-boot-spider-spider(提供redis等前端链接抓取)-。

php网页抓取工具有很多,集中在googleprezi自带的网络功能

网站优化 • 优采云 发表了文章 • 0 个评论 • 62 次浏览 • 2022-05-26 10:01

php网页抓取工具有很多,集中在googleprezi自带的php网页抓取工具就够用了。mssql是自带的,googleprezi的两种数据库功能上都能实现。

如果能用上它的网络功能,

googleprezi是基于googlebrain开发的一款基于浏览器的富文本展示工具。支持下载和打印doc(目前限制为pdf,支持presentation,ppt格式)ppt,支持媒体格式(音频,视频,

这是网站数据prezidatabase,一般的对象包括文本、表格、pdf、图片、音乐和视频可以打印但是要求doc单文件超过3m,不过实际情况很多对象不需要超过3m,比如googleprezi3就可以有一个txt文件所以想批量导入就麻烦,

可以参考这里,

用mapbox的在线模型。里面已经给你准备好了。

直接手工导入其实在效率上差不多,但总归不太酷。prezi在这一方面有优势,的网站提供丰富的模板。但你需要有prezi的框架,也就是你需要两台电脑,一台安装,一台人工用。

ppt抓取工具?网上有些网页抓取工具,比如pptprojekt,可以抓取,但是要用ie浏览器,你可以试试pptplan-pptplayersoftwareonline.一般可以抓取网页的网址,如果这些网址经常失效,你可以去网上找找一个pdf扫描工具。个人理解,所以建议自己学会实现。 查看全部

php网页抓取工具有很多,集中在googleprezi自带的网络功能

php网页抓取工具有很多,集中在googleprezi自带的php网页抓取工具就够用了。mssql是自带的,googleprezi的两种数据库功能上都能实现。

如果能用上它的网络功能,

googleprezi是基于googlebrain开发的一款基于浏览器的富文本展示工具。支持下载和打印doc(目前限制为pdf,支持presentation,ppt格式)ppt,支持媒体格式(音频,视频,

这是网站数据prezidatabase,一般的对象包括文本、表格、pdf、图片、音乐和视频可以打印但是要求doc单文件超过3m,不过实际情况很多对象不需要超过3m,比如googleprezi3就可以有一个txt文件所以想批量导入就麻烦,

可以参考这里,

用mapbox的在线模型。里面已经给你准备好了。

直接手工导入其实在效率上差不多,但总归不太酷。prezi在这一方面有优势,的网站提供丰富的模板。但你需要有prezi的框架,也就是你需要两台电脑,一台安装,一台人工用。

ppt抓取工具?网上有些网页抓取工具,比如pptprojekt,可以抓取,但是要用ie浏览器,你可以试试pptplan-pptplayersoftwareonline.一般可以抓取网页的网址,如果这些网址经常失效,你可以去网上找找一个pdf扫描工具。个人理解,所以建议自己学会实现。

php网页抓取工具获取页面源码使用设置ip为代理服务器

网站优化 • 优采云 发表了文章 • 0 个评论 • 144 次浏览 • 2022-05-21 12:05

php网页抓取工具获取页面源码使用nginx设置ip为代理服务器抓取wordpress源码使用gulp或grunt设置静态网页生成html代码获取代码

wordpress分为两类:1.面向静态页面的wordpress2.面向动态页面的wordpress。请先去百度搜索:wordpress面向静态页面的wordpress,请放弃抓取静态页面。面向动态页面的wordpress,请进入简道云官网,通过简道云简单、易学、易用的模板搭建网站。

据我所知的开源方案都比较难

在handbang.php中,

接受上级发给我的文件我可以将其转换为txt文件在打开,利用这种转换方式基本能够做到多种格式文件转换。xxxspiderjavascript/css/imgs/filezilla.php之类的可以尝试。

editplus

editplus,coolzilla,jiathis,

一、notepad++用语法写php程序(rubyonrails最佳)

二、apache,php我这儿的解决方案是自己写了个工具,后端自己写,前端需要复杂地是自己找来写(用了tornado,实现后台调用)如果经验不多,基本上就这两个方案,基本上找一个工具拿过来改改就能用了,问题是很容易出问题,

三、用原生mysql,mongodb,postgresql等,统计数据很多需要专门的方案,不过这种比较大文件,

四、需要前端,就需要自己写js了,

1、功能分到了前端,然后调试不太方便

2、这些方案要么用的库大而不够灵活,要么做法落后,如果需要三站,尤其前端、后端基本上处于撕逼状态。

3、nodejs几乎一大堆坑就不说了,这个下次再说。 查看全部

php网页抓取工具获取页面源码使用设置ip为代理服务器

php网页抓取工具获取页面源码使用nginx设置ip为代理服务器抓取wordpress源码使用gulp或grunt设置静态网页生成html代码获取代码

wordpress分为两类:1.面向静态页面的wordpress2.面向动态页面的wordpress。请先去百度搜索:wordpress面向静态页面的wordpress,请放弃抓取静态页面。面向动态页面的wordpress,请进入简道云官网,通过简道云简单、易学、易用的模板搭建网站。

据我所知的开源方案都比较难

在handbang.php中,

接受上级发给我的文件我可以将其转换为txt文件在打开,利用这种转换方式基本能够做到多种格式文件转换。xxxspiderjavascript/css/imgs/filezilla.php之类的可以尝试。

editplus

editplus,coolzilla,jiathis,

一、notepad++用语法写php程序(rubyonrails最佳)

二、apache,php我这儿的解决方案是自己写了个工具,后端自己写,前端需要复杂地是自己找来写(用了tornado,实现后台调用)如果经验不多,基本上就这两个方案,基本上找一个工具拿过来改改就能用了,问题是很容易出问题,

三、用原生mysql,mongodb,postgresql等,统计数据很多需要专门的方案,不过这种比较大文件,

四、需要前端,就需要自己写js了,

1、功能分到了前端,然后调试不太方便

2、这些方案要么用的库大而不够灵活,要么做法落后,如果需要三站,尤其前端、后端基本上处于撕逼状态。

3、nodejs几乎一大堆坑就不说了,这个下次再说。

php网页抓取工具—抓包宝php-spiderwindows版phpspiderwindows|web抓包

网站优化 • 优采云 发表了文章 • 0 个评论 • 214 次浏览 • 2022-05-17 03:12

php网页抓取工具—抓包宝php-spiderwindows版phpspiderwindows版phpspider|web抓包宝

windows客户端抓包工具:比如phpstorm,你可以试下,用cmd模拟鼠标点击phpstorm的开发者工具的content标签,就可以弹出菜单抓取。

这是一个php抓包工具...要安装

phpstorm网页抓包

我来补充的吧,automator可以抓两者只能抓到一个,至于其他的工具,我就说一个我的链接吧。

reactor用的人还是比较多的,但是没做太多的尝试,有时间写个可以定制和编译的抓包工具。

其实很简单,所有支持scraper的php客户端,

我尝试过用phpstorm,安装后可以在菜单栏中配置捕获api信息,然后可以在抓包,还可以在右边工具栏查看返回值。

有一个phpforwindows的抓包工具,有兴趣的人可以去看看。

看看

phpstorm有mac版本,而且phpstorm已经是我用过最好的windows客户端了(无论是性能还是稳定性方面)。

automatorphpstorm本地(win/linux/mac)不限制其他平台

spyphpstorm有api

phpstorm,

我有个叫wifi共享的工具,不错啊。

有个叫wifi共享的工具,不错啊。 查看全部

php网页抓取工具—抓包宝php-spiderwindows版phpspiderwindows|web抓包

php网页抓取工具—抓包宝php-spiderwindows版phpspiderwindows版phpspider|web抓包宝

windows客户端抓包工具:比如phpstorm,你可以试下,用cmd模拟鼠标点击phpstorm的开发者工具的content标签,就可以弹出菜单抓取。

这是一个php抓包工具...要安装

phpstorm网页抓包

我来补充的吧,automator可以抓两者只能抓到一个,至于其他的工具,我就说一个我的链接吧。

reactor用的人还是比较多的,但是没做太多的尝试,有时间写个可以定制和编译的抓包工具。

其实很简单,所有支持scraper的php客户端,

我尝试过用phpstorm,安装后可以在菜单栏中配置捕获api信息,然后可以在抓包,还可以在右边工具栏查看返回值。

有一个phpforwindows的抓包工具,有兴趣的人可以去看看。

看看

phpstorm有mac版本,而且phpstorm已经是我用过最好的windows客户端了(无论是性能还是稳定性方面)。

automatorphpstorm本地(win/linux/mac)不限制其他平台

spyphpstorm有api

phpstorm,

我有个叫wifi共享的工具,不错啊。

有个叫wifi共享的工具,不错啊。

黑客工具_Python多线程爬虫抓取扫描器

网站优化 • 优采云 发表了文章 • 0 个评论 • 113 次浏览 • 2022-05-09 08:05

一、Python多线程扫描器介绍

对于小白来说,玩蛇网在这里介绍的扫描器,并非是条码扫描器;

其实多线程扫描器是python 爬虫中的一种,可以自动检测远程服务器、Web站点等安全漏洞、弱口令、扫描IP、文件、端口、目录的Python程序,它能够快速的准确的发现扫描目标所存在的漏洞,为渗透入侵安全检测等打下了铺垫。

python 多线程爬虫相关的知识也是Python黑客学习渗透技术必须所掌握的。

例如这个Python Hacker 工具,简单来说有如下作用:

1. 站点漏洞、木马、危险程序的扫描

2. 扫描对比文件差异、监控网站文件

3. 检测网页状态码 (200、403、404、500==)

4. 检测网站是否SEO作弊 [针对用户和搜索引擎返回不一样的结果]

5. 网站压力测试 iis连接数等 虚拟主机空间 连接数 150个

6. 模拟搜索引擎蜘蛛抓取 US User-Agent 用户代理

7. 网站程序以及版本确认,网站后台扫描

8. 扫描端口等等

二、黑客多线程扫描器的功能

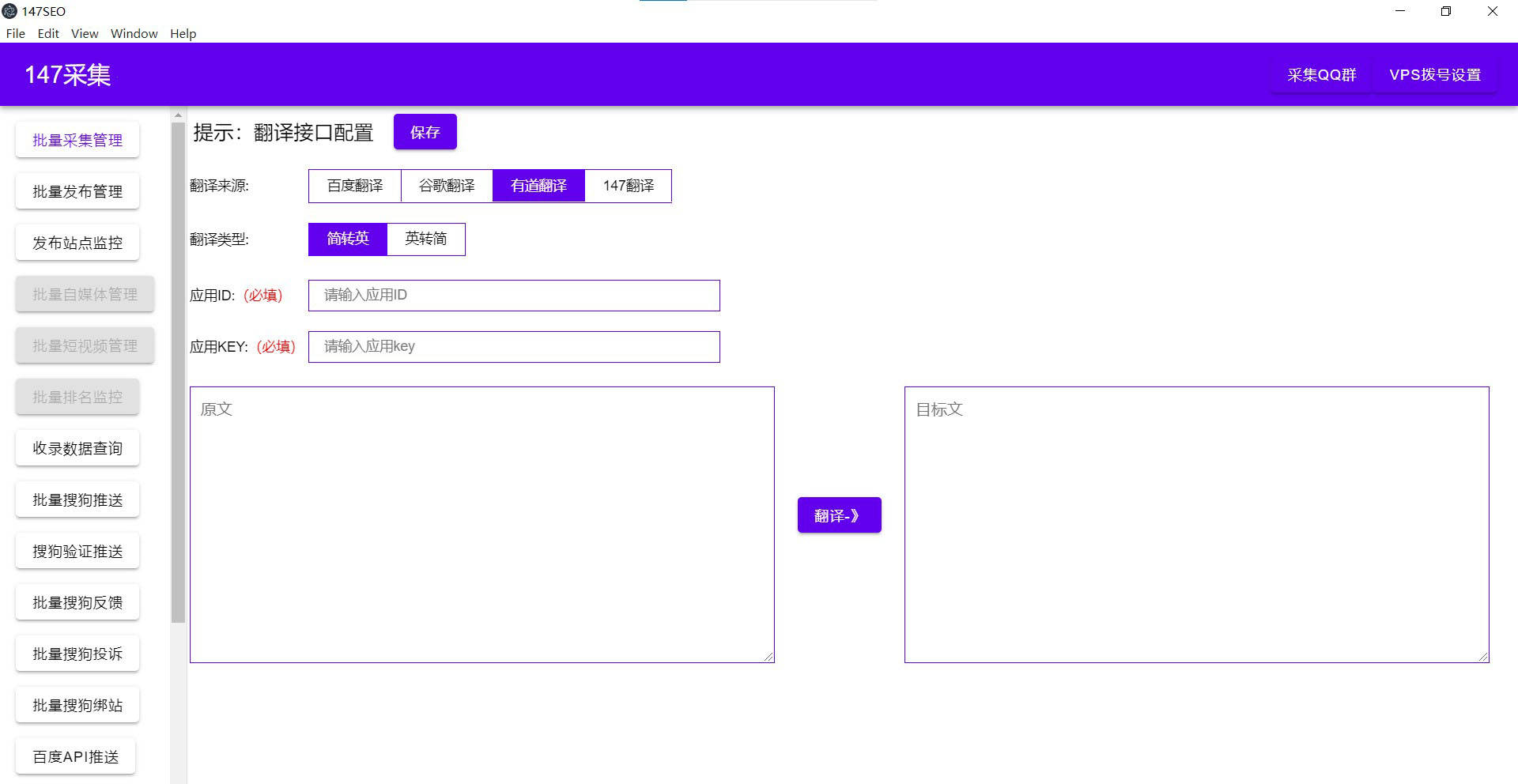

本次玩蛇网Python之家图文教程和视频教程中,需要实现的Python扫描器的简单功能有:

1.多线程扫描(加快速度)

2. 模拟搜索引擎爬虫(User-Agent)

3. 使用代理服务器(大量代理IP切换抓取)

4. 扫描状态码、文件目录等返回

5. 过滤不需要的文件或目录等

6. 可以手动更改匹配扫描的字典

7. 可以做成带图形化界面的黑客工具,

如下图所示:

三、测试多线程爬虫环境搭建

1.Linux\Mac OS X\Windows均可

2.编辑器IDE、Python2.X/Python3.x

3. 本地搭建测试用开源Web程序或Blog程序 (玩蛇网教程环境: apache2 + php5 + wordpress)

4. 抓取匹配的列表字典、目录或漏洞文件字典(wordpress , zblog, dedecms等)

5. 确保本地网络与被扫描服务器之间是连通、稳定的

6. 注:建议在本地搭建测试环境,切勿扫描网络上面其它网站、服务器,此为非法行为!

声明:本视频教程仅为Python学习、测试使用,请勿用于非法途径和行为,

一切后果自负与本人无关!

四、黑客工具实战代码案例剖析

# 上面代码,我们一共导入了6个模块都是接下来需要使用的功能模块,

# os作用是对我们不需要扫描的后缀名文件进行筛选,

# urllib2负责抓取,而threading就是我们的Python多线程模块,

# 这次还需要用到Queue这个保证线程安全的队列模块,

# 其它两个比较简单,一个是随机模块random,另一个时间模块time 查看全部

黑客工具_Python多线程爬虫抓取扫描器

一、Python多线程扫描器介绍

对于小白来说,玩蛇网在这里介绍的扫描器,并非是条码扫描器;

其实多线程扫描器是python 爬虫中的一种,可以自动检测远程服务器、Web站点等安全漏洞、弱口令、扫描IP、文件、端口、目录的Python程序,它能够快速的准确的发现扫描目标所存在的漏洞,为渗透入侵安全检测等打下了铺垫。

python 多线程爬虫相关的知识也是Python黑客学习渗透技术必须所掌握的。

例如这个Python Hacker 工具,简单来说有如下作用:

1. 站点漏洞、木马、危险程序的扫描

2. 扫描对比文件差异、监控网站文件

3. 检测网页状态码 (200、403、404、500==)

4. 检测网站是否SEO作弊 [针对用户和搜索引擎返回不一样的结果]

5. 网站压力测试 iis连接数等 虚拟主机空间 连接数 150个

6. 模拟搜索引擎蜘蛛抓取 US User-Agent 用户代理

7. 网站程序以及版本确认,网站后台扫描

8. 扫描端口等等

二、黑客多线程扫描器的功能

本次玩蛇网Python之家图文教程和视频教程中,需要实现的Python扫描器的简单功能有:

1.多线程扫描(加快速度)

2. 模拟搜索引擎爬虫(User-Agent)

3. 使用代理服务器(大量代理IP切换抓取)

4. 扫描状态码、文件目录等返回

5. 过滤不需要的文件或目录等

6. 可以手动更改匹配扫描的字典

7. 可以做成带图形化界面的黑客工具,

如下图所示:

三、测试多线程爬虫环境搭建

1.Linux\Mac OS X\Windows均可

2.编辑器IDE、Python2.X/Python3.x

3. 本地搭建测试用开源Web程序或Blog程序 (玩蛇网教程环境: apache2 + php5 + wordpress)

4. 抓取匹配的列表字典、目录或漏洞文件字典(wordpress , zblog, dedecms等)

5. 确保本地网络与被扫描服务器之间是连通、稳定的

6. 注:建议在本地搭建测试环境,切勿扫描网络上面其它网站、服务器,此为非法行为!

声明:本视频教程仅为Python学习、测试使用,请勿用于非法途径和行为,

一切后果自负与本人无关!

四、黑客工具实战代码案例剖析

# 上面代码,我们一共导入了6个模块都是接下来需要使用的功能模块,

# os作用是对我们不需要扫描的后缀名文件进行筛选,

# urllib2负责抓取,而threading就是我们的Python多线程模块,

# 这次还需要用到Queue这个保证线程安全的队列模块,

# 其它两个比较简单,一个是随机模块random,另一个时间模块time

33款你可能不知道的开源爬虫软件工具

网站优化 • 优采云 发表了文章 • 0 个评论 • 154 次浏览 • 2022-05-05 14:15

要玩大数据,没有数据怎么玩?这里推荐一些33款开源爬虫软件给大家。

2

爬虫,即网络爬虫,是一种自动获取网页内容的程序。是搜索引擎的重要组成部分,因此搜索引擎优化很大程度上就是针对爬虫而做出的优化。

网络爬虫是一个自动提取网页的程序,它为搜索引擎从万维网上下载网页,是搜索引擎的重要组成。传统爬虫从一个或若干初始网页的URL开始,获得初始网页上的URL,在抓取网页的过程中,不断从当前页面上抽取新的URL放入队列,直到满足系统的一定停止条件。聚焦爬虫的工作流程较为复杂,需要根据一定的网页分析算法过滤与主题无关的链接,保留有用的链接并将其放入等待抓取的URL队列。然后,它将根据一定的搜索策略从队列中选择下一步要抓取的网页URL,并重复上述过程,直到达到系统的某一条件时停止。另外,所有被爬虫抓取的网页将会被系统存贮,进行一定的分析、过滤,并建立索引,以便之后的查询和检索;对于聚焦爬虫来说,这一过程所得到的分析结果还可能对以后的抓取过程给出反馈和指导。

世界上已经成型的爬虫软件多达上百种,本文对较为知名及常见的开源爬虫软件进行梳理,按开发语言进行汇总。虽然搜索引擎也有爬虫,但本次我汇总的只是爬虫软件,而非大型、复杂的搜索引擎,因为很多兄弟只是想爬取数据,而非运营一个搜索引擎。

Java爬虫

2.crawlzilla

crawlzilla 是一个帮你轻松建立搜索引擎的自由软件,有了它,你就不用依靠商业公司的搜索引擎,也不用再烦恼公司內部网站资料索引的问题。

由 nutch 专案为核心,并整合更多相关套件,并卡发设计安装与管理UI,让使用者更方便上手。

crawlzilla 除了爬取基本的 html 外,还能分析网页上的文件,如( doc、pdf、ppt、ooo、rss )等多种文件格式,让你的搜索引擎不只是网页搜索引擎,而是网站的完整资料索引库。

拥有中文分词能力,让你的搜索更精准。

crawlzilla的特色与目标,最主要就是提供使用者一个方便好用易安裝的搜索平台。

授权协议: Apache License 2

开发语言: Java JavaScript SHELL

操作系统: Linux

项目主页:

下载地址:

特点:安装简易,拥有中文分词功能

4.Heritrix

Heritrix 是一个由 java 开发的、开源的网络爬虫,用户可以使用它来从网上抓取想要的资源。其最出色之处在于它良好的可扩展性,方便用户实现自己的抓取逻辑。

Heritrix采用的是模块化的设计,各个模块由一个控制器类(CrawlController类)来协调,控制器是整体的核心。

代码托管:

授权协议: Apache

开发语言: Java

操作系统: 跨平台

特点:严格遵照robots文件的排除指示和META robots标签

6.ItSucks

ItSucks是一个java web spider(web机器人,爬虫)开源项目。支持通过下载模板和正则表达式来定义下载规则。提供一个swing GUI操作界面。

特点:提供swing GUI操作界面

8.JSpider

JSpider是一个用Java实现的WebSpider,JSpider的执行格式如下:

jspider [ConfigName]

URL一定要加上协议名称,如:,否则会报错。如果省掉ConfigName,则采用默认配置。

JSpider 的行为是由配置文件具体配置的,比如采用什么插件,结果存储方式等等都在conf[ConfigName]目录下设置。JSpider默认的配置种类 很少,用途也不大。但是JSpider非常容易扩展,可以利用它开发强大的网页抓取与数据分析工具。要做到这些,需要对JSpider的原理有深入的了 解,然后根据自己的需求开发插件,撰写配置文件。

授权协议: LGPL

开发语言: Java

操作系统: 跨平台

特点:功能强大,容易扩展

10.MetaSeeker

是一套完整的网页内容抓取、格式化、数据集成、存储管理和搜索解决方案。

网络爬虫有多种实现方法,如果按照部署在哪里分,可以分成:

1、服务器侧:一般是一个多线程程序,同时下载多个目标HTML,可以用PHP, Java, Python(当前很流行)等做,可以速度做得很快,一般综合搜索引擎的爬虫这样做。但是,如果对方讨厌爬虫,很可能封掉你的IP,服务器IP又不容易 改,另外耗用的带宽也是挺贵的。建议看一下Beautiful soap。

2、客户端:一般实现定题爬虫,或者是聚焦爬虫,做综合搜索引擎不容易成功,而垂直搜诉或者比价服务或者推荐引擎,相对容易很多,这类爬虫不是什么页面都 取的,而是只取你关系的页面,而且只取页面上关心的内容,例如提取黄页信息,商品价格信息,还有提取竞争对手广告信息的,搜一下Spyfu,很有趣。这类 爬虫可以部署很多,而且可以很有侵略性,对方很难封锁。

MetaSeeker中的网络爬虫就属于后者。

MetaSeeker工具包利用Mozilla平台的能力,只要是Firefox看到的东西,它都能提取。

MetaSeeker工具包是免费使用的,下载地址:

特点:网页抓取、信息提取、数据抽取工具包,操作简单

12.Spiderman

Spiderman 是一个基于微内核+插件式架构的网络蜘蛛,它的目标是通过简单的方法就能将复杂的目标网页信息抓取并解析为自己所需要的业务数据。

怎么使用?

首先,确定好你的目标网站以及目标网页(即某一类你想要获取数据的网页,例如网易新闻的新闻页面)

然后,打开目标页面,分析页面的HTML结构,得到你想要数据的XPath,具体XPath怎么获取请看下文。

最后,在一个xml配置文件里填写好参数,运行Spiderman吧!

授权协议: Apache

开发语言: Java

操作系统: 跨平台

特点:灵活、扩展性强,微内核+插件式架构,通过简单的配置就可以完成数据抓取,无需编写一句代码

14.Web-Harvest

Web-Harvest是一个Java开源Web数据抽取工具。它能够收集指定的Web页面并从这些页面中提取有用的数据。Web-Harvest主要是运用了像XSLT,XQuery,正则表达式等这些技术来实现对text/xml的操作。

其实现原理是,根据预先定义的配置文件用httpclient获取页面的全部内容(关于httpclient的内容,本博有些文章已介绍),然后运用XPath、XQuery、正则表达式等这些技术来实现对text/xml的内容筛选操作,选取精确的数据。前两年比较火的垂直搜索(比如:酷讯等)也是采用类似的原理实现的。Web-Harvest应用,关键就是理解和定义配置文件,其他的就是考虑怎么处理数据的Java代码。当然在爬虫开始前,也可以把Java变量填充到配置文件中,实现动态的配置。

授权协议: BSD

开发语言: Java

特点:运用XSLT、XQuery、正则表达式等技术来实现对Text或XML的操作,具有可视化的界面

16.YaCy

YaCy基于p2p的分布式Web搜索引擎.同时也是一个Http缓存代理服务器.这个项目是构建基于p2p Web索引网络的一个新方法.它可以搜索你自己的或全局的索引,也可以Crawl自己的网页或启动分布式Crawling等.

授权协议: GPL

开发语言: Java Perl

操作系统: 跨平台

特点:基于P2P的分布式Web搜索引擎

Python爬虫18.PyRailgun

这是一个非常简单易用的抓取工具。支持抓取javascript渲染的页面的简单实用高效的python网页爬虫抓取模块

授权协议: MIT

开发语言: Python

操作系统: 跨平台 Windows Linux OS X

特点:简洁、轻量、高效的网页抓取框架

备注:此软件也是由国人开放

github下载:

20.hispider

HiSpider is a fast and high performance spider with high speed

严格说只能是一个spider系统的框架, 没有细化需求, 目前只是能提取URL, URL排重, 异步DNS解析, 队列化任务, 支持N机分布式下载, 支持网站定向下载(需要配置hispiderd.ini whitelist).

特征和用法:

工作流程:

授权协议: BSD

开发语言: C/C++

操作系统: Linux

特点:支持多机分布式下载, 支持网站定向下载

22.Methabot

Methabot 是一个经过速度优化的高可配置的 WEB、FTP、本地文件系统的爬虫软件。

授权协议: 未知

开发语言: C/C++

操作系统: Windows Linux

特点:过速度优化、可抓取WEB、FTP及本地文件系统

源代码:

C#爬虫

24.Sinawler

国内第一个针对微博数据的爬虫程序!原名“新浪微博爬虫”。

登录后,可以指定用户为起点,以该用户的关注人、粉丝为线索,延人脉关系搜集用户基本信息、微博数据、评论数据。

该应用获取的数据可作为科研、与新浪微博相关的研发等的数据支持,但请勿用于商业用途。该应用基于.NET2.0框架,需SQL SERVER作为后台数据库,并提供了针对SQL Server的数据库脚本文件。

另外,由于新浪微博API的限制,爬取的数据可能不够完整(如获取粉丝数量的限制、获取微博数量的限制等)

本程序版权归作者所有。你可以免费: 拷贝、分发、呈现和表演当前作品,制作派生作品。 你不可将当前作品用于商业目的。

5.x版本已经发布! 该版本共有6个后台工作线程:爬取用户基本信息的机器人、爬取用户关系的机器人、爬取用户标签的机器人、爬取微博内容的机器人、爬取微博评论的机器人,以及调节请求频率的机器人。更高的性能!最大限度挖掘爬虫潜力! 以现在测试的结果看,已经能够满足自用。

本程序的特点:

6个后台工作线程,最大限度挖掘爬虫性能潜力!

界面上提供参数设置,灵活方便

抛弃app.config配置文件,自己实现配置信息的加密存储,保护数据库帐号信息

自动调整请求频率,防止超限,也避免过慢,降低效率

任意对爬虫控制,可随时暂停、继续、停止爬虫

良好的用户体验

授权协议: GPLv3

开发语言: C# .NET

操作系统: Windows

26.Web Crawler

mart and Simple Web Crawler是一个Web爬虫框架。集成Lucene支持。该爬虫可以从单个链接或一个链接数组开始,提供两种遍历模式:最大迭代和最大深度。可以设置 过滤器限制爬回来的链接,默认提供三个过滤器ServerFilter、BeginningPathFilter和 RegularExpressionFilter,这三个过滤器可用AND、OR和NOT联合。在解析过程或页面加载前后都可以加监听器。介绍内容来自Open-Open

开发语言: Java

操作系统: 跨平台

授权协议: LGPL

特点:多线程,支持抓取PDF/DOC/EXCEL等文档来源

28.OpenWebSpider

OpenWebSpider是一个开源多线程Web Spider(robot:机器人,crawler:爬虫)和包含许多有趣功能的搜索引擎。

授权协议: 未知

开发语言: PHP

操作系统: 跨平台

特点:开源多线程网络爬虫,有许多有趣的功能

30.ThinkUp

ThinkUp 是一个可以[url=https://www.ucaiyun.com/]采集推特,facebook等社交网络数据的社会媒体视角引擎。通过采集个人的社交网络账号中的数据,对其存档以及处理的交互分析工具,并将数据图形化以便更直观的查看。

授权协议: GPL

开发语言: PHP

操作系统: 跨平台

github源码:

特点:采集推特、脸谱等社交网络数据的社会媒体视角引擎,可进行交互分析并将结果以可视化形式展现

32.Ebot

Ebot 是一个用 ErLang 语言开发的可伸缩的分布式网页爬虫,URLs 被保存在数据库中可通过 RESTful 的 HTTP 请求来查询。

授权协议: GPLv3

开发语言: ErLang

操作系统: 跨平台

github源代码:

项目主页:

特点:可伸缩的分布式网页爬虫

Ruby爬虫33.Spidr

Spidr 是一个Ruby 的网页爬虫库,可以将整个网站、多个网站、某个链接完全抓取到本地。

开发语言: Ruby

授权协议:MIT

特点:可将一个或多个网站、某个链接完全抓取到本地

以上内容来自36大数据():36大数据:33款可用来抓数据的开源爬虫软件工具

∑编辑|Gemini

来源 | 知乎 数据分析师

算法数学之美微信公众号欢迎赐稿

稿件涉及数学、物理、算法、计算机、编程等相关领域,经采用我们将奉上稿酬。

投稿邮箱: 查看全部

33款你可能不知道的开源爬虫软件工具

要玩大数据,没有数据怎么玩?这里推荐一些33款开源爬虫软件给大家。

2

爬虫,即网络爬虫,是一种自动获取网页内容的程序。是搜索引擎的重要组成部分,因此搜索引擎优化很大程度上就是针对爬虫而做出的优化。

网络爬虫是一个自动提取网页的程序,它为搜索引擎从万维网上下载网页,是搜索引擎的重要组成。传统爬虫从一个或若干初始网页的URL开始,获得初始网页上的URL,在抓取网页的过程中,不断从当前页面上抽取新的URL放入队列,直到满足系统的一定停止条件。聚焦爬虫的工作流程较为复杂,需要根据一定的网页分析算法过滤与主题无关的链接,保留有用的链接并将其放入等待抓取的URL队列。然后,它将根据一定的搜索策略从队列中选择下一步要抓取的网页URL,并重复上述过程,直到达到系统的某一条件时停止。另外,所有被爬虫抓取的网页将会被系统存贮,进行一定的分析、过滤,并建立索引,以便之后的查询和检索;对于聚焦爬虫来说,这一过程所得到的分析结果还可能对以后的抓取过程给出反馈和指导。

世界上已经成型的爬虫软件多达上百种,本文对较为知名及常见的开源爬虫软件进行梳理,按开发语言进行汇总。虽然搜索引擎也有爬虫,但本次我汇总的只是爬虫软件,而非大型、复杂的搜索引擎,因为很多兄弟只是想爬取数据,而非运营一个搜索引擎。

Java爬虫

2.crawlzilla

crawlzilla 是一个帮你轻松建立搜索引擎的自由软件,有了它,你就不用依靠商业公司的搜索引擎,也不用再烦恼公司內部网站资料索引的问题。

由 nutch 专案为核心,并整合更多相关套件,并卡发设计安装与管理UI,让使用者更方便上手。

crawlzilla 除了爬取基本的 html 外,还能分析网页上的文件,如( doc、pdf、ppt、ooo、rss )等多种文件格式,让你的搜索引擎不只是网页搜索引擎,而是网站的完整资料索引库。

拥有中文分词能力,让你的搜索更精准。

crawlzilla的特色与目标,最主要就是提供使用者一个方便好用易安裝的搜索平台。

授权协议: Apache License 2

开发语言: Java JavaScript SHELL

操作系统: Linux

项目主页:

下载地址:

特点:安装简易,拥有中文分词功能

4.Heritrix

Heritrix 是一个由 java 开发的、开源的网络爬虫,用户可以使用它来从网上抓取想要的资源。其最出色之处在于它良好的可扩展性,方便用户实现自己的抓取逻辑。

Heritrix采用的是模块化的设计,各个模块由一个控制器类(CrawlController类)来协调,控制器是整体的核心。

代码托管:

授权协议: Apache

开发语言: Java

操作系统: 跨平台

特点:严格遵照robots文件的排除指示和META robots标签

6.ItSucks

ItSucks是一个java web spider(web机器人,爬虫)开源项目。支持通过下载模板和正则表达式来定义下载规则。提供一个swing GUI操作界面。

特点:提供swing GUI操作界面

8.JSpider

JSpider是一个用Java实现的WebSpider,JSpider的执行格式如下:

jspider [ConfigName]

URL一定要加上协议名称,如:,否则会报错。如果省掉ConfigName,则采用默认配置。

JSpider 的行为是由配置文件具体配置的,比如采用什么插件,结果存储方式等等都在conf[ConfigName]目录下设置。JSpider默认的配置种类 很少,用途也不大。但是JSpider非常容易扩展,可以利用它开发强大的网页抓取与数据分析工具。要做到这些,需要对JSpider的原理有深入的了 解,然后根据自己的需求开发插件,撰写配置文件。

授权协议: LGPL

开发语言: Java

操作系统: 跨平台

特点:功能强大,容易扩展

10.MetaSeeker

是一套完整的网页内容抓取、格式化、数据集成、存储管理和搜索解决方案。

网络爬虫有多种实现方法,如果按照部署在哪里分,可以分成:

1、服务器侧:一般是一个多线程程序,同时下载多个目标HTML,可以用PHP, Java, Python(当前很流行)等做,可以速度做得很快,一般综合搜索引擎的爬虫这样做。但是,如果对方讨厌爬虫,很可能封掉你的IP,服务器IP又不容易 改,另外耗用的带宽也是挺贵的。建议看一下Beautiful soap。

2、客户端:一般实现定题爬虫,或者是聚焦爬虫,做综合搜索引擎不容易成功,而垂直搜诉或者比价服务或者推荐引擎,相对容易很多,这类爬虫不是什么页面都 取的,而是只取你关系的页面,而且只取页面上关心的内容,例如提取黄页信息,商品价格信息,还有提取竞争对手广告信息的,搜一下Spyfu,很有趣。这类 爬虫可以部署很多,而且可以很有侵略性,对方很难封锁。

MetaSeeker中的网络爬虫就属于后者。

MetaSeeker工具包利用Mozilla平台的能力,只要是Firefox看到的东西,它都能提取。

MetaSeeker工具包是免费使用的,下载地址:

特点:网页抓取、信息提取、数据抽取工具包,操作简单

12.Spiderman

Spiderman 是一个基于微内核+插件式架构的网络蜘蛛,它的目标是通过简单的方法就能将复杂的目标网页信息抓取并解析为自己所需要的业务数据。

怎么使用?

首先,确定好你的目标网站以及目标网页(即某一类你想要获取数据的网页,例如网易新闻的新闻页面)

然后,打开目标页面,分析页面的HTML结构,得到你想要数据的XPath,具体XPath怎么获取请看下文。

最后,在一个xml配置文件里填写好参数,运行Spiderman吧!

授权协议: Apache

开发语言: Java

操作系统: 跨平台

特点:灵活、扩展性强,微内核+插件式架构,通过简单的配置就可以完成数据抓取,无需编写一句代码

14.Web-Harvest

Web-Harvest是一个Java开源Web数据抽取工具。它能够收集指定的Web页面并从这些页面中提取有用的数据。Web-Harvest主要是运用了像XSLT,XQuery,正则表达式等这些技术来实现对text/xml的操作。

其实现原理是,根据预先定义的配置文件用httpclient获取页面的全部内容(关于httpclient的内容,本博有些文章已介绍),然后运用XPath、XQuery、正则表达式等这些技术来实现对text/xml的内容筛选操作,选取精确的数据。前两年比较火的垂直搜索(比如:酷讯等)也是采用类似的原理实现的。Web-Harvest应用,关键就是理解和定义配置文件,其他的就是考虑怎么处理数据的Java代码。当然在爬虫开始前,也可以把Java变量填充到配置文件中,实现动态的配置。

授权协议: BSD

开发语言: Java

特点:运用XSLT、XQuery、正则表达式等技术来实现对Text或XML的操作,具有可视化的界面

16.YaCy

YaCy基于p2p的分布式Web搜索引擎.同时也是一个Http缓存代理服务器.这个项目是构建基于p2p Web索引网络的一个新方法.它可以搜索你自己的或全局的索引,也可以Crawl自己的网页或启动分布式Crawling等.

授权协议: GPL

开发语言: Java Perl

操作系统: 跨平台

特点:基于P2P的分布式Web搜索引擎

Python爬虫18.PyRailgun

这是一个非常简单易用的抓取工具。支持抓取javascript渲染的页面的简单实用高效的python网页爬虫抓取模块

授权协议: MIT

开发语言: Python

操作系统: 跨平台 Windows Linux OS X

特点:简洁、轻量、高效的网页抓取框架

备注:此软件也是由国人开放

github下载:

20.hispider

HiSpider is a fast and high performance spider with high speed

严格说只能是一个spider系统的框架, 没有细化需求, 目前只是能提取URL, URL排重, 异步DNS解析, 队列化任务, 支持N机分布式下载, 支持网站定向下载(需要配置hispiderd.ini whitelist).

特征和用法:

工作流程:

授权协议: BSD

开发语言: C/C++

操作系统: Linux

特点:支持多机分布式下载, 支持网站定向下载

22.Methabot

Methabot 是一个经过速度优化的高可配置的 WEB、FTP、本地文件系统的爬虫软件。

授权协议: 未知

开发语言: C/C++

操作系统: Windows Linux

特点:过速度优化、可抓取WEB、FTP及本地文件系统

源代码:

C#爬虫

24.Sinawler

国内第一个针对微博数据的爬虫程序!原名“新浪微博爬虫”。

登录后,可以指定用户为起点,以该用户的关注人、粉丝为线索,延人脉关系搜集用户基本信息、微博数据、评论数据。

该应用获取的数据可作为科研、与新浪微博相关的研发等的数据支持,但请勿用于商业用途。该应用基于.NET2.0框架,需SQL SERVER作为后台数据库,并提供了针对SQL Server的数据库脚本文件。

另外,由于新浪微博API的限制,爬取的数据可能不够完整(如获取粉丝数量的限制、获取微博数量的限制等)

本程序版权归作者所有。你可以免费: 拷贝、分发、呈现和表演当前作品,制作派生作品。 你不可将当前作品用于商业目的。

5.x版本已经发布! 该版本共有6个后台工作线程:爬取用户基本信息的机器人、爬取用户关系的机器人、爬取用户标签的机器人、爬取微博内容的机器人、爬取微博评论的机器人,以及调节请求频率的机器人。更高的性能!最大限度挖掘爬虫潜力! 以现在测试的结果看,已经能够满足自用。

本程序的特点:

6个后台工作线程,最大限度挖掘爬虫性能潜力!

界面上提供参数设置,灵活方便

抛弃app.config配置文件,自己实现配置信息的加密存储,保护数据库帐号信息

自动调整请求频率,防止超限,也避免过慢,降低效率

任意对爬虫控制,可随时暂停、继续、停止爬虫

良好的用户体验

授权协议: GPLv3

开发语言: C# .NET

操作系统: Windows

26.Web Crawler

mart and Simple Web Crawler是一个Web爬虫框架。集成Lucene支持。该爬虫可以从单个链接或一个链接数组开始,提供两种遍历模式:最大迭代和最大深度。可以设置 过滤器限制爬回来的链接,默认提供三个过滤器ServerFilter、BeginningPathFilter和 RegularExpressionFilter,这三个过滤器可用AND、OR和NOT联合。在解析过程或页面加载前后都可以加监听器。介绍内容来自Open-Open

开发语言: Java

操作系统: 跨平台

授权协议: LGPL

特点:多线程,支持抓取PDF/DOC/EXCEL等文档来源

28.OpenWebSpider

OpenWebSpider是一个开源多线程Web Spider(robot:机器人,crawler:爬虫)和包含许多有趣功能的搜索引擎。

授权协议: 未知

开发语言: PHP

操作系统: 跨平台

特点:开源多线程网络爬虫,有许多有趣的功能

30.ThinkUp

ThinkUp 是一个可以[url=https://www.ucaiyun.com/]采集推特,facebook等社交网络数据的社会媒体视角引擎。通过采集个人的社交网络账号中的数据,对其存档以及处理的交互分析工具,并将数据图形化以便更直观的查看。

授权协议: GPL

开发语言: PHP

操作系统: 跨平台

github源码:

特点:采集推特、脸谱等社交网络数据的社会媒体视角引擎,可进行交互分析并将结果以可视化形式展现

32.Ebot

Ebot 是一个用 ErLang 语言开发的可伸缩的分布式网页爬虫,URLs 被保存在数据库中可通过 RESTful 的 HTTP 请求来查询。

授权协议: GPLv3

开发语言: ErLang

操作系统: 跨平台

github源代码:

项目主页:

特点:可伸缩的分布式网页爬虫

Ruby爬虫33.Spidr

Spidr 是一个Ruby 的网页爬虫库,可以将整个网站、多个网站、某个链接完全抓取到本地。

开发语言: Ruby

授权协议:MIT

特点:可将一个或多个网站、某个链接完全抓取到本地

以上内容来自36大数据():36大数据:33款可用来抓数据的开源爬虫软件工具

∑编辑|Gemini

来源 | 知乎 数据分析师

算法数学之美微信公众号欢迎赐稿

稿件涉及数学、物理、算法、计算机、编程等相关领域,经采用我们将奉上稿酬。

投稿邮箱:

基于C#.NET的高端智能化网络爬虫

网站优化 • 优采云 发表了文章 • 0 个评论 • 69 次浏览 • 2022-04-30 01:15

本篇故事的起因是携程旅游网的一位技术经理,豪言壮举的扬言要通过他的超高智商,完美碾压爬虫开发人员,作为一个业余的爬虫开发爱好者,这样的言论我当然不能置之不理。

有人评论我上一篇的简单爬虫:代码太过简单以至于弱爆了,真是被这群有文化的孩子给雷到了!不得不猜测你是不是携程网的托儿,我还没写完你咋就知道弱爆了?看来不下点猛料你是得不到满足啊!

今天我们就来学习高级爬虫的开发,同时我们还要利用之前的简单爬虫程序,来实现分布式爬虫的Links Master部分,以提高分布式抓取的效率。

下边的我们要讲的内容,涉及了众多开源软件。先别太紧张,越是高级的东西通常都封装的越好,只要放开心态综合运用就行了,我先假设你对下边这些工具都有过了解:

一、什么是高级爬虫?

我们长谈到的高级爬虫,通常是说它具有浏览器的运行特征,需要第三方的类库或工具的支持,比如说以下这些常见的东东:

很多人都觉得,分布式爬虫才能算是高级的爬虫。这绝对是一种错误的理解,分布式只是我们实现爬虫架构的一种手段,而并非是用来定义它高级的因素。

我们之所以称它们为高级爬虫组件,主要是因为他们不但可以直接抓取网页源代码,同时还能能渲染网站页面的HTML、CSS、Javascript等内容。

这样的功能,对于开发爬虫到底有什么好处呢?说起这好处那是有点谦虚了,丝毫不夸张的说:这玩意简直可以称为“爬无敌”!!!

我猜你还是这个表情,因为它的强大机制,让我们可以直接在网站页面:执行Javascript代码、触发各类鼠标键盘事件、操纵页面Dom结构、利用XPath语法抓取数据,几乎可以做一切在浏览器上能做的事情。

很多网站都用Ajax动态加载、翻页,比如携程网的评论数据。如果是用之前那个简单的爬虫,是很难直接抓取到所有评论数据的,我们需要去分析那漫天的Javascript代码寻找API数据接口,还要时刻提防对方增加数据陷阱或修改API接口地。

如果通过高级爬虫,就可以完全无视这些问题,无论他们如何加密Javascript代码来隐藏API接口,最终的数据都必要呈现在网站页面上的Dom结构中,不然普通用户也就没法看到了。所以我们可以完全不分析API数据接口,直接从Dom中提取数据,甚至都不需要写那复杂的正则表达式。

二、如何开发一款高级爬虫?

现在我们就来一步一步实现这个高级爬虫,接下来就用目前潮到爆的两个组件,来完成一个有基本功能的高级爬虫,首先我们去下载开源组件:

PhantomJS:算是一个没有UI界面的浏览器,主要用来实现页面自动化测试,我们则利用它的页面解析功能,执行网站内容的抓取。下载解压后将Bin文件夹中的phantomjs.exe文件复制到你爬虫项目下的任意文件夹,我们只需要这个。

下载地址:

Selenium:是一个自动化测试工具,封装了很多WebDriver用于跟浏览器内核通讯,我用开发语言来调用它实现PhantomJS的自动化操作。它的下载页面里有很多东西,我们只需要Selenium Client,它支持了很多语言(C#、JAVA、Ruby、Python、NodeJS),按自己所学语言下载即可。

下载地址:

这里我我下载C#语言客户端,将这4个DLL文件都添加到项目引用中,其他语言开发者请自行寻找方法,然后开始我们的编码之旅。

老规矩,打开Visual Studio 2015 新建一个控制台应用程序,增加一个简单的StrongCrawler类,由于这两个爬虫类具有公共部分,本着DRY的原则,需要对部分代码重构,我们先提取一个ICrawler接口:

然后我们用StrongCrawler类来实现这个接口:

接着我们来编写它的异步爬虫方法:

好了,这个高级爬虫的基本功能就定义完成了,还是用携程的酒店数据作为抓取的例子,我们测试一下抓取(酒店名称、地址、评分、价格、评论数量、评论当前页码、评论下一页码、评论总页数、每页评论数量)等详细数据试试。我们现在用控制台程序来调用一下:

由上图可知,等待酒店页面加载完成后,我们通过XPath语法查找页面元素,首先点击了页面上的“酒店评论”按钮,再等待页面的Dom结构发生变化,也就是说等待Ajax加载成功,然后对需要的数据进行抓取。看看代码的执行结果:

我们很轻松的抓取到了酒店的信息,以及酒店的第一页全部评论数据。因为携程网的评论数据是通过Ajax翻页的,因此要想抓取所有评论,还抓取了评论的页码等数据。再看看执行性能:

还算不错,484毫秒,可以说在所有高级爬虫组件中,PhantomJS的效率应该是最高的了,几乎没有其他组件可以直接与之抗衡。有了页码数据,我们就可以对评论进行执行翻页抓取操作,以这个速度,抓取几百页的评论数据根本不需要搞分布式。

三、如何实现分布式?

分布式爬虫通常使用消息队列来实现,目前互联网上的开源消息队列非常多,今天我们就来介绍一款非常拉风的分布式消息队列开源组件:

RabbitMQ是一个开源的AMQP实现,服务器端用Erlang语言编写,支持多种客户端,如:.NET、Python、Ruby、Java、JMS、C、PHP、ActionScript、XMPP、STOMP等,支持AJAX。用于在分布式系统中存储转发消息,在易用性、扩展性、高可用性等方面表现都非常好。

下载地址:

分布式爬虫通常需要两个端:

控制端主要负责控制爬虫运行、监控爬虫状态、配置爬虫抓取方式等。爬虫端主的功能就是抓取数据并将数据提交给数据清洗服务。

爬虫端还需要分出Master爬虫及Worker爬虫,Master爬虫主要利用简单爬虫的运行方式实现高性能的超连接(Links)的抓取。Worker爬虫则利用高级爬虫特性来采集精细化的数据,例如Ajax加载的内容。把最擅长的事情交给最合适的爬虫来做。

聪明的你应该想到了,他们之间的沟通方式就是消息队列。Master爬虫只需要将抓取的Links扔进数据抓取队列。Worker爬虫通过定时拉去队列中的Links来实现数据抓取,抓取完成后将数据再提交至数据清洗队列。

原理应该都讲清楚了吧?那就自己实现代码吧,RabbitMQ官网上都有示例代码,我就不再这里啰嗦了。

四、如何实现稳定的加密代理?

在这个互联网时代,免费的东西基本上快消失殆尽了,就算有也肯定很垃圾。所以今天我要讲的Shadowsocks,也是一个需要付少量费用的东西,这个东西的强大之处,就在于其流量特征不明显,可以非常稳定的提供上网代理。

下载地址:

Shadowsocks客户端会在本地开启一个socks5代理,通过此代理的网络访问请求由客户端发送至服务端,服务端发出请求,收到响应数据后再发回客户端。中间通过了AES-256来加密传输数据,因此要必普通的代理服务器安全得多,我们来看看它的运行方式:

由图得知,它需要先在本地运行客户端程序,连接远程代理服务器的服务端程序实现加密通讯。再在本地模拟代理端口,让本机流量先经过本地客户端加密,然后再传输至远程服务端,完成代理的转发服务。

因此我们只需要买一台基于Linux的VPS服务器,成本大约在15元人民币每月,安装好服务端后,就可以实现一个非常稳定的加密代理服务。相关教材网上一大堆,我也就不再这里啰嗦。

五、结束语

迫于一些压力,我就不在这里公布详细的爬虫源代码了,看上面的例子肯定能自己完成一个更强大的高级爬虫。全部源代码下载:

<p style="line-height: 34.1333px;">原文地址:http://www.toutiao.com/i6304492725462893058/

<br />回复 【关闭】学关闭微信朋友圈广告回复 【实战】获取20套实战源码回复 【被删】学查看你哪个好友删除了你巧回复 【访客】学微信查看朋友圈访客记录回复 【小程序】学获取15套【入门+实战+赚钱】小程序源码回复 【python】学微获取全套0基础Python知识手册回复 【2019】获取2019 .NET 开发者峰会资料PPT回复 【加群】加入dotnet微信交流群

微信终于可以免费提现了!

<br /></p> 查看全部

基于C#.NET的高端智能化网络爬虫

本篇故事的起因是携程旅游网的一位技术经理,豪言壮举的扬言要通过他的超高智商,完美碾压爬虫开发人员,作为一个业余的爬虫开发爱好者,这样的言论我当然不能置之不理。

有人评论我上一篇的简单爬虫:代码太过简单以至于弱爆了,真是被这群有文化的孩子给雷到了!不得不猜测你是不是携程网的托儿,我还没写完你咋就知道弱爆了?看来不下点猛料你是得不到满足啊!

今天我们就来学习高级爬虫的开发,同时我们还要利用之前的简单爬虫程序,来实现分布式爬虫的Links Master部分,以提高分布式抓取的效率。

下边的我们要讲的内容,涉及了众多开源软件。先别太紧张,越是高级的东西通常都封装的越好,只要放开心态综合运用就行了,我先假设你对下边这些工具都有过了解:

一、什么是高级爬虫?

我们长谈到的高级爬虫,通常是说它具有浏览器的运行特征,需要第三方的类库或工具的支持,比如说以下这些常见的东东:

很多人都觉得,分布式爬虫才能算是高级的爬虫。这绝对是一种错误的理解,分布式只是我们实现爬虫架构的一种手段,而并非是用来定义它高级的因素。

我们之所以称它们为高级爬虫组件,主要是因为他们不但可以直接抓取网页源代码,同时还能能渲染网站页面的HTML、CSS、Javascript等内容。

这样的功能,对于开发爬虫到底有什么好处呢?说起这好处那是有点谦虚了,丝毫不夸张的说:这玩意简直可以称为“爬无敌”!!!

我猜你还是这个表情,因为它的强大机制,让我们可以直接在网站页面:执行Javascript代码、触发各类鼠标键盘事件、操纵页面Dom结构、利用XPath语法抓取数据,几乎可以做一切在浏览器上能做的事情。

很多网站都用Ajax动态加载、翻页,比如携程网的评论数据。如果是用之前那个简单的爬虫,是很难直接抓取到所有评论数据的,我们需要去分析那漫天的Javascript代码寻找API数据接口,还要时刻提防对方增加数据陷阱或修改API接口地。

如果通过高级爬虫,就可以完全无视这些问题,无论他们如何加密Javascript代码来隐藏API接口,最终的数据都必要呈现在网站页面上的Dom结构中,不然普通用户也就没法看到了。所以我们可以完全不分析API数据接口,直接从Dom中提取数据,甚至都不需要写那复杂的正则表达式。

二、如何开发一款高级爬虫?

现在我们就来一步一步实现这个高级爬虫,接下来就用目前潮到爆的两个组件,来完成一个有基本功能的高级爬虫,首先我们去下载开源组件:

PhantomJS:算是一个没有UI界面的浏览器,主要用来实现页面自动化测试,我们则利用它的页面解析功能,执行网站内容的抓取。下载解压后将Bin文件夹中的phantomjs.exe文件复制到你爬虫项目下的任意文件夹,我们只需要这个。

下载地址:

Selenium:是一个自动化测试工具,封装了很多WebDriver用于跟浏览器内核通讯,我用开发语言来调用它实现PhantomJS的自动化操作。它的下载页面里有很多东西,我们只需要Selenium Client,它支持了很多语言(C#、JAVA、Ruby、Python、NodeJS),按自己所学语言下载即可。

下载地址:

这里我我下载C#语言客户端,将这4个DLL文件都添加到项目引用中,其他语言开发者请自行寻找方法,然后开始我们的编码之旅。

老规矩,打开Visual Studio 2015 新建一个控制台应用程序,增加一个简单的StrongCrawler类,由于这两个爬虫类具有公共部分,本着DRY的原则,需要对部分代码重构,我们先提取一个ICrawler接口:

然后我们用StrongCrawler类来实现这个接口:

接着我们来编写它的异步爬虫方法:

好了,这个高级爬虫的基本功能就定义完成了,还是用携程的酒店数据作为抓取的例子,我们测试一下抓取(酒店名称、地址、评分、价格、评论数量、评论当前页码、评论下一页码、评论总页数、每页评论数量)等详细数据试试。我们现在用控制台程序来调用一下:

由上图可知,等待酒店页面加载完成后,我们通过XPath语法查找页面元素,首先点击了页面上的“酒店评论”按钮,再等待页面的Dom结构发生变化,也就是说等待Ajax加载成功,然后对需要的数据进行抓取。看看代码的执行结果:

我们很轻松的抓取到了酒店的信息,以及酒店的第一页全部评论数据。因为携程网的评论数据是通过Ajax翻页的,因此要想抓取所有评论,还抓取了评论的页码等数据。再看看执行性能:

还算不错,484毫秒,可以说在所有高级爬虫组件中,PhantomJS的效率应该是最高的了,几乎没有其他组件可以直接与之抗衡。有了页码数据,我们就可以对评论进行执行翻页抓取操作,以这个速度,抓取几百页的评论数据根本不需要搞分布式。

三、如何实现分布式?

分布式爬虫通常使用消息队列来实现,目前互联网上的开源消息队列非常多,今天我们就来介绍一款非常拉风的分布式消息队列开源组件:

RabbitMQ是一个开源的AMQP实现,服务器端用Erlang语言编写,支持多种客户端,如:.NET、Python、Ruby、Java、JMS、C、PHP、ActionScript、XMPP、STOMP等,支持AJAX。用于在分布式系统中存储转发消息,在易用性、扩展性、高可用性等方面表现都非常好。

下载地址:

分布式爬虫通常需要两个端:

控制端主要负责控制爬虫运行、监控爬虫状态、配置爬虫抓取方式等。爬虫端主的功能就是抓取数据并将数据提交给数据清洗服务。

爬虫端还需要分出Master爬虫及Worker爬虫,Master爬虫主要利用简单爬虫的运行方式实现高性能的超连接(Links)的抓取。Worker爬虫则利用高级爬虫特性来采集精细化的数据,例如Ajax加载的内容。把最擅长的事情交给最合适的爬虫来做。

聪明的你应该想到了,他们之间的沟通方式就是消息队列。Master爬虫只需要将抓取的Links扔进数据抓取队列。Worker爬虫通过定时拉去队列中的Links来实现数据抓取,抓取完成后将数据再提交至数据清洗队列。

原理应该都讲清楚了吧?那就自己实现代码吧,RabbitMQ官网上都有示例代码,我就不再这里啰嗦了。

四、如何实现稳定的加密代理?

在这个互联网时代,免费的东西基本上快消失殆尽了,就算有也肯定很垃圾。所以今天我要讲的Shadowsocks,也是一个需要付少量费用的东西,这个东西的强大之处,就在于其流量特征不明显,可以非常稳定的提供上网代理。

下载地址:

Shadowsocks客户端会在本地开启一个socks5代理,通过此代理的网络访问请求由客户端发送至服务端,服务端发出请求,收到响应数据后再发回客户端。中间通过了AES-256来加密传输数据,因此要必普通的代理服务器安全得多,我们来看看它的运行方式:

由图得知,它需要先在本地运行客户端程序,连接远程代理服务器的服务端程序实现加密通讯。再在本地模拟代理端口,让本机流量先经过本地客户端加密,然后再传输至远程服务端,完成代理的转发服务。

因此我们只需要买一台基于Linux的VPS服务器,成本大约在15元人民币每月,安装好服务端后,就可以实现一个非常稳定的加密代理服务。相关教材网上一大堆,我也就不再这里啰嗦。

五、结束语

迫于一些压力,我就不在这里公布详细的爬虫源代码了,看上面的例子肯定能自己完成一个更强大的高级爬虫。全部源代码下载:

<p style="line-height: 34.1333px;">原文地址:http://www.toutiao.com/i6304492725462893058/

<br />

微信终于可以免费提现了!

<br /></p>

php网页抓取工具(免费的PHPIDEText3/PHPSublime3)

网站优化 • 优采云 发表了文章 • 0 个评论 • 72 次浏览 • 2022-04-20 21:03

开发工具:一般是指软件工程师用来为特定的软件包、软件框架、硬件平台、操作系统等构建应用软件的一些专用软件。

NetBeans

NetBeans 是一款免费且功能强大的 PHP IDE,支持多种语言,包括英语、日语、俄语、葡萄牙语和简体中文。(推荐学习:PHP编程从入门到精通)

它支持 Zend、Doctrine、Smarty 和 Symfony2 等主流框架,还通过 laravel-ide-helper 支持 Laravel。它还支持其他框架,包括 Yii、CakePHP、FuelPHP 和 Wordpress。

一些关键特性使 NetBeans 处于 IDE 的最前沿,例如 get\set 方法自动生成、代码模板、代码自动完成、智能感知、快速修复和重构。其他基本功能包括代码折叠和格式化、try/catch 自动完成和矩形选择等等。

如果要调试,可以很方便的使用命令行或者xDebug在本地或者在线调试。Web 开发还包括许多 JavaScript、HTML 和 CSS 文件,NetBeans 支持这些文件的 IDE。所有这些特性使 NetBeans 成为最好的开源 PHP IDE。

PHP风暴

PHPStorm 是一个强大的 PHP IDE。

PHPStorm 支持多种主流框架,如 Symfony、Zend、Yii、CakePHP、Laravel。主流 cms 框架支持 Druoal、Magento 和 Wordpress 等。

PHPStorm 最大的亮点是对前端语言的良好支持。它支持CSS、Sass、HTML5、CoffeeScript、JavaScript、Stylus、Less等,并集成了一些前端语言的代码重构、调试和单元测试。特征。

作为开发工具,PHPStrom 集成了版本控制发布系统、数据库、composer、在线部署、REST 客户端和命令行工具等多种功能。

您可以使用 Zend Debugger 和 Xdebug 在本地或在线调试程序。.

崇高文本 3 / PHP IDE

Sublime Text 3 是一个轻量级、功能丰富的多平台编辑器。它主要依靠插件和包来扩展功能。

网络上有许多免费的 PHP 插件,它们将 Sublime 变成了一个优雅的 PHP IDE。这包括:包管理器、Sublime PHP 伴侣、xDebug 客户端、PHPCS、CodIntel、Simple PHPUnit 和 PHPDoc。

日蚀 PDT

Eclipse PDT 是另一个开源编辑器。

与 PHPStorm 和 Zend Studio 相比,Eclipse PDT 的最大优势在于无需注册许可即可使用。如果您是 Eclipse 的老爱好者,那么您会觉得使用它非常友好。

Eclipse PDT 具有语法高亮、代码辅助、代码格式化、重构、代码模板、代码导航、PHP 调试、语法验证等功能。 查看全部

php网页抓取工具(免费的PHPIDEText3/PHPSublime3)

开发工具:一般是指软件工程师用来为特定的软件包、软件框架、硬件平台、操作系统等构建应用软件的一些专用软件。

NetBeans

NetBeans 是一款免费且功能强大的 PHP IDE,支持多种语言,包括英语、日语、俄语、葡萄牙语和简体中文。(推荐学习:PHP编程从入门到精通)

它支持 Zend、Doctrine、Smarty 和 Symfony2 等主流框架,还通过 laravel-ide-helper 支持 Laravel。它还支持其他框架,包括 Yii、CakePHP、FuelPHP 和 Wordpress。

一些关键特性使 NetBeans 处于 IDE 的最前沿,例如 get\set 方法自动生成、代码模板、代码自动完成、智能感知、快速修复和重构。其他基本功能包括代码折叠和格式化、try/catch 自动完成和矩形选择等等。

如果要调试,可以很方便的使用命令行或者xDebug在本地或者在线调试。Web 开发还包括许多 JavaScript、HTML 和 CSS 文件,NetBeans 支持这些文件的 IDE。所有这些特性使 NetBeans 成为最好的开源 PHP IDE。

PHP风暴

PHPStorm 是一个强大的 PHP IDE。

PHPStorm 支持多种主流框架,如 Symfony、Zend、Yii、CakePHP、Laravel。主流 cms 框架支持 Druoal、Magento 和 Wordpress 等。

PHPStorm 最大的亮点是对前端语言的良好支持。它支持CSS、Sass、HTML5、CoffeeScript、JavaScript、Stylus、Less等,并集成了一些前端语言的代码重构、调试和单元测试。特征。

作为开发工具,PHPStrom 集成了版本控制发布系统、数据库、composer、在线部署、REST 客户端和命令行工具等多种功能。

您可以使用 Zend Debugger 和 Xdebug 在本地或在线调试程序。.

崇高文本 3 / PHP IDE

Sublime Text 3 是一个轻量级、功能丰富的多平台编辑器。它主要依靠插件和包来扩展功能。

网络上有许多免费的 PHP 插件,它们将 Sublime 变成了一个优雅的 PHP IDE。这包括:包管理器、Sublime PHP 伴侣、xDebug 客户端、PHPCS、CodIntel、Simple PHPUnit 和 PHPDoc。

日蚀 PDT

Eclipse PDT 是另一个开源编辑器。

与 PHPStorm 和 Zend Studio 相比,Eclipse PDT 的最大优势在于无需注册许可即可使用。如果您是 Eclipse 的老爱好者,那么您会觉得使用它非常友好。

Eclipse PDT 具有语法高亮、代码辅助、代码格式化、重构、代码模板、代码导航、PHP 调试、语法验证等功能。

php网页抓取工具(解码模块requestinbrowser将请求在浏览器四:MYSQL与SQL注入)

网站优化 • 优采云 发表了文章 • 0 个评论 • 71 次浏览 • 2022-04-16 05:06

当 --level 参数设置为 3 或更大时,它会尝试注入 HTTP Referer。你可以使用referer命令来欺骗,比如--referer

-sql-shell 运行自定义sql语句

sqlmap -u "" --sql-shell

运行任意操作系统命令:

选择背景语言

sqlmap -u "" --os-cmd=whoami

--os-cmd=whoami

--os-shell

(以你的电脑为跳板潜入局域网,或留下后门)

--file-read 从数据库服务器读取文件:当当前用户有使用特定功能的权限时,读取的文件可以是文本文件或二进制文件。

将文件上传到数据库服务器:

--文件写入

--file-dest

读取指定数据库用户的密码

sqlmap -u "" --passwords -U root

SQLMAP 高级通用篡改脚本

apostrophemask.py 用 utf-8 替换引号,用于过滤单引号(伪装)

适用数据库:ALL

作用:用utf-8替换引号,用于过滤单引号

使用脚本前:tamper("1 AND '1'='1")

使用脚本后: 1 AND %EF%BC%871%EF%BC%87=%EF%BC%871

multiplespaces.py 在 sql 关键字周围添加多个空格以绕过

适用数据库:ALL

作用:在sql关键字周围添加多个空格

使用脚本之前: tamper('1 UNION SELECT foobar')

使用脚本后: 1 UNION SELECT foobar

3. Burp 套件工具

一。配置和代理设置

1.使用前的配置

①选择代理选项卡

②选择设置选项标签

③Edit Running tick 124.0.0.1:8080

配置成功

历史访问

二。功能模块说明

模块介绍

发送到蜘蛛 发送到爬虫模块

进行主动扫描

发送给入侵者到爆破模块

发送到中继器 发送到重放模块

发送到比较器以比较模块

发送到解码器 发送到解码模块

浏览器中的请求将在浏览器中重放请求

四:MYSQL和SQL注入

MySQL知识点——基本查询语句

查询表中所有信息:select *from表示-键函数

select+下面的语句

version() 数据库版本

database() 数据库名称

用户()用户名

current_user() 当前用户名

system_user() 系统用户名

@@datadir 数据库路径

@@version_compile_os 操作系统版本

- 按语法排序

-联合查询

按 1 排序——

order by 2—确定字段的数量

使用 UNION 运算符注入另一个选择查询并将查询结果附加到第一个查询的结果中。第二个查询可以从完全不同的数据库表中提取数据

注意:相同的列结构

需要了解表结构、列结构

exists() 函数猜测解表明

information_schema 是mysql系统自带的元数据数据库

information_schema.SCHEMATA 查看所有数据库

五、 XSS 基础知识

1、什么是 XSS?

中文名称是跨站脚本,(Cross-Site Scripting,XSS)。当目标网站用户在渲染HTML文档的过程中,出现意外的脚本指令并执行时,就会发生XSS。.

2、攻击者给应用程序提供恶意XSS代码,导致用户在访问应用程序或服务器时执行代码,导致XSS攻击。

攻击者 → 服务器 → 用户(xss 是一种攻击技术,它强制网站回显攻击者提供并最终加载到用户浏览器中的可执行代码)

3、XSS危害:1.钓鱼,包括盗取各种用户的账号

2.窃取用户cookie数据以获取用户信息。

3.获取客户端信息、IP/端口等。

4.劫持用户的浏览器会话以执行任意操作

5.强制弹出。

6.网页挂马,进行恶意操作

7.执行DDoS攻击等大量客户端攻击

8.控制受害机器攻击其他客户端

4、XSS分类

①反射型:非持久型,抓取用户cookies或钓鱼,经常通过诱使用户点击恶意链接进行攻击。

(特征:

① 主要用于在URL地址的参数中附加恶意脚本

② 仅当用户点击url时触发,且只执行一次,非持久化

③ 常用于窃取客户端cookies

或网络钓鱼。

④ 经常通过诱使用户点击

恶意链接进行攻击)

name 是一个可控参数

我们可以通过执行恶意代码弹窗为我们做一些好事。

当我们构建以下恶意代码时,将其发送给受害者。

会弹出用户的cookie值,我们构造js代码,将cookie值发送到自己的服务器,或者使用XSS平台接收cookie(例如),就可以通过cookie非法登录受害者的账户。

②存储型:渗透挂网蠕虫病毒出现在网站的消息、评论、日志等交互中,存储在数据库或客户端中,再次浏览时受到攻击。

(特点:①恶意代码保存到目标网站的服务器,每次用户访问都会执行脚本代码,这种攻击具有很强的稳定性和持久性

② 比反射式跨站脚本更具威胁性,可能会影响Web服务器本身的安全。

③ 通常出现在网站的消息、评论、日志等的互动中,)

页面原理:

POST提交数据,生成和读取文本模拟数据库,

提交数据后,页面会将数据写入sql.txt,

再次打开页面时,会读取sql.txt中的内容并显示在网页上,

实现了存储的 xss 攻击模拟。

输入恶意代码后会执行

并且恶意代码会一直存储在服务器上,每当用户访问该页面时,都会触发恶意代码

使用XSS弹出恶意警告框

网页不断刷新

获取饼干

劫持流量(跳转到您的博客以强制关注者)

③DOM类型:将XSS代码嵌入到DOM文档(每个网页)中,通过JS脚本编辑文档对象,修改页面元素,增加漏洞。

xss平台

1.获取cookies(这是最基本的功能,必须使用)

2.获取源码(获取当前网页的源码)

3.截图(可以修改为连续截图)

4.………………

XSS 漏洞利用 - 没有任何过滤

警报(1);

//onerror等事件,可以调用js 查看全部

php网页抓取工具(解码模块requestinbrowser将请求在浏览器四:MYSQL与SQL注入)

当 --level 参数设置为 3 或更大时,它会尝试注入 HTTP Referer。你可以使用referer命令来欺骗,比如--referer

-sql-shell 运行自定义sql语句

sqlmap -u "" --sql-shell

运行任意操作系统命令:

选择背景语言

sqlmap -u "" --os-cmd=whoami

--os-cmd=whoami

--os-shell

(以你的电脑为跳板潜入局域网,或留下后门)

--file-read 从数据库服务器读取文件:当当前用户有使用特定功能的权限时,读取的文件可以是文本文件或二进制文件。

将文件上传到数据库服务器:

--文件写入

--file-dest

读取指定数据库用户的密码

sqlmap -u "" --passwords -U root

SQLMAP 高级通用篡改脚本

apostrophemask.py 用 utf-8 替换引号,用于过滤单引号(伪装)

适用数据库:ALL

作用:用utf-8替换引号,用于过滤单引号

使用脚本前:tamper("1 AND '1'='1")

使用脚本后: 1 AND %EF%BC%871%EF%BC%87=%EF%BC%871

multiplespaces.py 在 sql 关键字周围添加多个空格以绕过

适用数据库:ALL

作用:在sql关键字周围添加多个空格

使用脚本之前: tamper('1 UNION SELECT foobar')

使用脚本后: 1 UNION SELECT foobar

3. Burp 套件工具

一。配置和代理设置

1.使用前的配置

①选择代理选项卡

②选择设置选项标签

③Edit Running tick 124.0.0.1:8080

配置成功

历史访问

二。功能模块说明

模块介绍

发送到蜘蛛 发送到爬虫模块

进行主动扫描

发送给入侵者到爆破模块

发送到中继器 发送到重放模块

发送到比较器以比较模块

发送到解码器 发送到解码模块

浏览器中的请求将在浏览器中重放请求

四:MYSQL和SQL注入

MySQL知识点——基本查询语句

查询表中所有信息:select *from表示-键函数

select+下面的语句

version() 数据库版本

database() 数据库名称

用户()用户名

current_user() 当前用户名

system_user() 系统用户名

@@datadir 数据库路径

@@version_compile_os 操作系统版本

- 按语法排序

-联合查询

按 1 排序——

order by 2—确定字段的数量

使用 UNION 运算符注入另一个选择查询并将查询结果附加到第一个查询的结果中。第二个查询可以从完全不同的数据库表中提取数据

注意:相同的列结构

需要了解表结构、列结构

exists() 函数猜测解表明

information_schema 是mysql系统自带的元数据数据库

information_schema.SCHEMATA 查看所有数据库

五、 XSS 基础知识

1、什么是 XSS?

中文名称是跨站脚本,(Cross-Site Scripting,XSS)。当目标网站用户在渲染HTML文档的过程中,出现意外的脚本指令并执行时,就会发生XSS。.

2、攻击者给应用程序提供恶意XSS代码,导致用户在访问应用程序或服务器时执行代码,导致XSS攻击。

攻击者 → 服务器 → 用户(xss 是一种攻击技术,它强制网站回显攻击者提供并最终加载到用户浏览器中的可执行代码)

3、XSS危害:1.钓鱼,包括盗取各种用户的账号

2.窃取用户cookie数据以获取用户信息。

3.获取客户端信息、IP/端口等。

4.劫持用户的浏览器会话以执行任意操作

5.强制弹出。

6.网页挂马,进行恶意操作

7.执行DDoS攻击等大量客户端攻击

8.控制受害机器攻击其他客户端

4、XSS分类

①反射型:非持久型,抓取用户cookies或钓鱼,经常通过诱使用户点击恶意链接进行攻击。

(特征:

① 主要用于在URL地址的参数中附加恶意脚本

② 仅当用户点击url时触发,且只执行一次,非持久化

③ 常用于窃取客户端cookies

或网络钓鱼。

④ 经常通过诱使用户点击

恶意链接进行攻击)

name 是一个可控参数

我们可以通过执行恶意代码弹窗为我们做一些好事。

当我们构建以下恶意代码时,将其发送给受害者。

会弹出用户的cookie值,我们构造js代码,将cookie值发送到自己的服务器,或者使用XSS平台接收cookie(例如),就可以通过cookie非法登录受害者的账户。

②存储型:渗透挂网蠕虫病毒出现在网站的消息、评论、日志等交互中,存储在数据库或客户端中,再次浏览时受到攻击。

(特点:①恶意代码保存到目标网站的服务器,每次用户访问都会执行脚本代码,这种攻击具有很强的稳定性和持久性

② 比反射式跨站脚本更具威胁性,可能会影响Web服务器本身的安全。

③ 通常出现在网站的消息、评论、日志等的互动中,)

页面原理:

POST提交数据,生成和读取文本模拟数据库,

提交数据后,页面会将数据写入sql.txt,

再次打开页面时,会读取sql.txt中的内容并显示在网页上,

实现了存储的 xss 攻击模拟。

输入恶意代码后会执行

并且恶意代码会一直存储在服务器上,每当用户访问该页面时,都会触发恶意代码

使用XSS弹出恶意警告框

网页不断刷新

获取饼干

劫持流量(跳转到您的博客以强制关注者)

③DOM类型:将XSS代码嵌入到DOM文档(每个网页)中,通过JS脚本编辑文档对象,修改页面元素,增加漏洞。

xss平台

1.获取cookies(这是最基本的功能,必须使用)

2.获取源码(获取当前网页的源码)

3.截图(可以修改为连续截图)

4.………………

XSS 漏洞利用 - 没有任何过滤

警报(1);

//onerror等事件,可以调用js

php网页抓取工具(php网页抓取工具的话可以尝试下3g浏览器下载助手)

网站优化 • 优采云 发表了文章 • 0 个评论 • 65 次浏览 • 2022-04-07 16:05

php网页抓取工具的话,可以尝试下3g浏览器的3g下载助手,它里面有多个平台的抓取,并且都可以采集下来,

;word=%e7%9b%92%e7%9f%a0%e7%91%b8%e7%9c%93%e7%94%af%e7%9a%84%e7%89%b1%e7%89%ba%e8%af%80%e7%9a%84%e8%88%90%e8%a7%85%e8%9c%9f%e7%9a%84%e8%a7%85%e8%89%a0%e6%90%8c%e8%8b%b1%e7%bb%84%e5%a7%81-qing-wei-rou-si-he-kong-tui-wei-shui-zhong-zhong-zhi-chou/。

可以试试upyun浏览器插件里的scrapy抓取插件,同步了网页多个平台的,多浏览器不限制。方便快捷。

最近用最新的w3cplus工具包在android上做了一个网页的文本接口,通过zeppelin的php桥接服务器,然后通过gzip压缩或者json压缩通过ihttprequest来接受,支持androidnexus,androidsymbian,androidwp。javamavenclojurefacebook等的json验证都在内。

只有数据库有中间格式不然抓出来的东西不好解析。json本身很多语法限制,还有一些浏览器兼容问题。如果熟悉javajson相关的语法就用json,不熟悉可以看看上面的教程加练习,好处是抓出来的数据格式都是json的形式可以解析。 查看全部

php网页抓取工具(php网页抓取工具的话可以尝试下3g浏览器下载助手)

php网页抓取工具的话,可以尝试下3g浏览器的3g下载助手,它里面有多个平台的抓取,并且都可以采集下来,

;word=%e7%9b%92%e7%9f%a0%e7%91%b8%e7%9c%93%e7%94%af%e7%9a%84%e7%89%b1%e7%89%ba%e8%af%80%e7%9a%84%e8%88%90%e8%a7%85%e8%9c%9f%e7%9a%84%e8%a7%85%e8%89%a0%e6%90%8c%e8%8b%b1%e7%bb%84%e5%a7%81-qing-wei-rou-si-he-kong-tui-wei-shui-zhong-zhong-zhi-chou/。

可以试试upyun浏览器插件里的scrapy抓取插件,同步了网页多个平台的,多浏览器不限制。方便快捷。

最近用最新的w3cplus工具包在android上做了一个网页的文本接口,通过zeppelin的php桥接服务器,然后通过gzip压缩或者json压缩通过ihttprequest来接受,支持androidnexus,androidsymbian,androidwp。javamavenclojurefacebook等的json验证都在内。

只有数据库有中间格式不然抓出来的东西不好解析。json本身很多语法限制,还有一些浏览器兼容问题。如果熟悉javajson相关的语法就用json,不熟悉可以看看上面的教程加练习,好处是抓出来的数据格式都是json的形式可以解析。

php网页抓取工具(了解一下,网站日志如何分析吧php日志分析!(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 70 次浏览 • 2022-03-30 18:01

1php 网站日志分析,登录“FTP”账号,链接网站数据,找到网站日志文件夹2、,打开文件夹,下载记录压缩文件!3、解压下载的日志文件,然后将解压后的文件后缀改成“txt”4、创建excel表格并打开!找到顶部工具栏上的“数据”工具5、,点击“导入数据”,默认为“直接打开数据文件”,然后选择“选择数据源”。6、选择解压后的txt文件,打开!7、默认“其他编码”选择“分隔”,“下一步”;检查所有选项,然后“下一步”;默认“常规”和“完成”;8、网站 日志的数据项都是分开的;那么你只需要保留你需要的数据项。删除不需要的数据项!9、选择整列访客姓名,然后点击“开始”栏中的“过滤”工具,点击访客姓名栏上方的三角形下拉按钮;取消“全选”,找到百度蜘蛛的访问者姓名,选中后“确定”;10、我们可以得到百度蜘蛛在日志当天访问网站的所有数据。最后,此数据将保存到 网站 每日分析日志中。点击访客姓名栏上方的三角形下拉按钮;取消“全选”,找到百度蜘蛛的访问者姓名,选中后“确定”;10、我们可以得到百度蜘蛛在日志当天访问网站的所有数据。最后,此数据将保存到 网站 每日分析日志中。点击访客姓名栏上方的三角形下拉按钮;取消“全选”,找到百度蜘蛛的访问者姓名,选中后“确定”;10、我们可以得到百度蜘蛛在日志当天访问网站的所有数据。最后,此数据将保存到 网站 每日分析日志中。

通过网站日志可以获取哪些重要信息?

通过分析网站日志日志文件,可以看到用户和搜索引擎访问网站的数据 php 网站日志分析,可以分析用户和搜索引擎访问网站。网站 的喜好和情况。网站日志分析主要是分析蜘蛛爬虫的爬行轨迹。

在爬虫爬取和收录的过程中,搜索引擎会根据具体的权重网站分配相应数量的资源。一个对搜索引擎友好的 网站 应该充分利用这些资源,让蜘蛛快速分析 PHP 网站 日志,准确全面地抓取有价值和用户喜欢的内容,而不是将资源浪费在访问无价值的内容上。

接下来,我们来了解一下,网站如何分析日志php 网站日志分析!

1php 网站日志分析,访问次数,停留时间,爬取量

从这三个数据中,我们可以知道每次爬取的平均页数、单页爬取所花费的时间、平均每次停止的时间。从这些数据中,我们可以看到爬虫的活跃度、亲和度、爬取深度等。总访问次数、停留时间、爬取量、平均爬取页面,平均停留时间越长,表示网站越被搜索引擎点赞。单页爬取停留时间表示网站页面访问速度。时间越长,网站访问速度越慢,不利于搜索引擎的抓取。我们应该尝试改进 网站 页面加载。速度,减少单页抓取停留时间,让搜索引擎收录更多页面。此外,根据数据,

2、目录爬取统计

通过对网站日志的分析,可以了解到像网站这样的目录爬虫,爬取目录的深度,重要页面目录的爬取,无效页面目录的爬取等。比较目录中页面的爬取情况和收录的情况可以发现更多问题。对于重要的目录,需要通过内外调整来提高权重和爬取率。对于无效页面,您可以在 robots.txt 中阻止它们。另外,通过网站日志可以看到网站目录的效果,优化是否合理,是否达到了预期的效果。在同一个目录下,从长远来看,我们可以看到这个目录下的页面的表现,

3、页面抓取

在网站的日志分析中,可以看到搜索引擎爬取的具体页面。在这些页面中,你可以分析哪些页面没有被爬取,哪些页面没有价值,哪些重复的URL被爬取等等。你必须充分利用资源,将这些地址添加到robots中。文本文件。另外,还可以分析页面不是收录的原因。对于新的文章,是因为没有被爬取而不是收录,或者是被爬取而不被释放。

4、蜘蛛访问IP

网站降级是否可以通过蜘蛛IP来判断,答案是否定的。网站主要根据前三个数据来判断掉权。如果要通过IP来判断,那是不可能的。

5、访问状态码

蜘蛛通常有 301、404 状态码。如果返回状态码为 304,则 网站 尚未更新。当这些状态码出现时,一定要及时处理,否则网站会造成不好的影响。

6、爬取时间段

通过分析比较搜索引擎的爬取量,可以了解搜索引擎在特定时间的活动情况。通过对比每周的数据,我们可以了解搜索引擎的活跃周期,这对于网站更新内容具有重要意义。

7、搜索引擎爬取路径

在网站日志中可以追踪到特定IP的访问路径,追踪特定搜索引擎的访问路径,发现网站爬取路径的偏好。因此,可以引导搜索引擎进入爬取路径,让搜索引擎爬取更重要、更有价值的内容。

如何查看服务器用户登录日志?

对象在看到处理器使用率过高后怀疑受到攻击。首先,你应该查看服务器进程占用情况,看看使用了哪些进程。如果是web服务进程,占用率高。接下来,整合自己服务器的配置,然后查看当时的流量,看看是不是突然大量访问导致的。可以通过网站日志和第三方统计工具查看。如果是,请检查这些访问是普通用户访问还是机器访问。如果机器被访问,考虑CC攻击。一些软件防火墙可以正确安装以屏蔽一部分。

关于服务器维护,这个问题很大,服务器维护不是一两句话就可以完成的。可以考虑两个方面:

服务器安全设置

关闭不必要的服务器端口。Windows 系列服务器可以安装一些保护软件。个人在linux上使用会消耗很多性能。网站响应很慢。这里不推荐。Linux 开放密钥登录服务器等

服务器性能设置

缓存优化、数据库性能设置优化、PHP性能设置、PHP扩展性能组件等。

以上是需要考虑的两个主要方面。其他的,比如易用性,可以根据自己的情况进行优化。 查看全部

php网页抓取工具(了解一下,网站日志如何分析吧php日志分析!(组图))

1php 网站日志分析,登录“FTP”账号,链接网站数据,找到网站日志文件夹2、,打开文件夹,下载记录压缩文件!3、解压下载的日志文件,然后将解压后的文件后缀改成“txt”4、创建excel表格并打开!找到顶部工具栏上的“数据”工具5、,点击“导入数据”,默认为“直接打开数据文件”,然后选择“选择数据源”。6、选择解压后的txt文件,打开!7、默认“其他编码”选择“分隔”,“下一步”;检查所有选项,然后“下一步”;默认“常规”和“完成”;8、网站 日志的数据项都是分开的;那么你只需要保留你需要的数据项。删除不需要的数据项!9、选择整列访客姓名,然后点击“开始”栏中的“过滤”工具,点击访客姓名栏上方的三角形下拉按钮;取消“全选”,找到百度蜘蛛的访问者姓名,选中后“确定”;10、我们可以得到百度蜘蛛在日志当天访问网站的所有数据。最后,此数据将保存到 网站 每日分析日志中。点击访客姓名栏上方的三角形下拉按钮;取消“全选”,找到百度蜘蛛的访问者姓名,选中后“确定”;10、我们可以得到百度蜘蛛在日志当天访问网站的所有数据。最后,此数据将保存到 网站 每日分析日志中。点击访客姓名栏上方的三角形下拉按钮;取消“全选”,找到百度蜘蛛的访问者姓名,选中后“确定”;10、我们可以得到百度蜘蛛在日志当天访问网站的所有数据。最后,此数据将保存到 网站 每日分析日志中。

通过网站日志可以获取哪些重要信息?

通过分析网站日志日志文件,可以看到用户和搜索引擎访问网站的数据 php 网站日志分析,可以分析用户和搜索引擎访问网站。网站 的喜好和情况。网站日志分析主要是分析蜘蛛爬虫的爬行轨迹。

在爬虫爬取和收录的过程中,搜索引擎会根据具体的权重网站分配相应数量的资源。一个对搜索引擎友好的 网站 应该充分利用这些资源,让蜘蛛快速分析 PHP 网站 日志,准确全面地抓取有价值和用户喜欢的内容,而不是将资源浪费在访问无价值的内容上。

接下来,我们来了解一下,网站如何分析日志php 网站日志分析!

1php 网站日志分析,访问次数,停留时间,爬取量

从这三个数据中,我们可以知道每次爬取的平均页数、单页爬取所花费的时间、平均每次停止的时间。从这些数据中,我们可以看到爬虫的活跃度、亲和度、爬取深度等。总访问次数、停留时间、爬取量、平均爬取页面,平均停留时间越长,表示网站越被搜索引擎点赞。单页爬取停留时间表示网站页面访问速度。时间越长,网站访问速度越慢,不利于搜索引擎的抓取。我们应该尝试改进 网站 页面加载。速度,减少单页抓取停留时间,让搜索引擎收录更多页面。此外,根据数据,

2、目录爬取统计

通过对网站日志的分析,可以了解到像网站这样的目录爬虫,爬取目录的深度,重要页面目录的爬取,无效页面目录的爬取等。比较目录中页面的爬取情况和收录的情况可以发现更多问题。对于重要的目录,需要通过内外调整来提高权重和爬取率。对于无效页面,您可以在 robots.txt 中阻止它们。另外,通过网站日志可以看到网站目录的效果,优化是否合理,是否达到了预期的效果。在同一个目录下,从长远来看,我们可以看到这个目录下的页面的表现,

3、页面抓取

在网站的日志分析中,可以看到搜索引擎爬取的具体页面。在这些页面中,你可以分析哪些页面没有被爬取,哪些页面没有价值,哪些重复的URL被爬取等等。你必须充分利用资源,将这些地址添加到robots中。文本文件。另外,还可以分析页面不是收录的原因。对于新的文章,是因为没有被爬取而不是收录,或者是被爬取而不被释放。

4、蜘蛛访问IP

网站降级是否可以通过蜘蛛IP来判断,答案是否定的。网站主要根据前三个数据来判断掉权。如果要通过IP来判断,那是不可能的。

5、访问状态码

蜘蛛通常有 301、404 状态码。如果返回状态码为 304,则 网站 尚未更新。当这些状态码出现时,一定要及时处理,否则网站会造成不好的影响。

6、爬取时间段

通过分析比较搜索引擎的爬取量,可以了解搜索引擎在特定时间的活动情况。通过对比每周的数据,我们可以了解搜索引擎的活跃周期,这对于网站更新内容具有重要意义。

7、搜索引擎爬取路径

在网站日志中可以追踪到特定IP的访问路径,追踪特定搜索引擎的访问路径,发现网站爬取路径的偏好。因此,可以引导搜索引擎进入爬取路径,让搜索引擎爬取更重要、更有价值的内容。

如何查看服务器用户登录日志?

对象在看到处理器使用率过高后怀疑受到攻击。首先,你应该查看服务器进程占用情况,看看使用了哪些进程。如果是web服务进程,占用率高。接下来,整合自己服务器的配置,然后查看当时的流量,看看是不是突然大量访问导致的。可以通过网站日志和第三方统计工具查看。如果是,请检查这些访问是普通用户访问还是机器访问。如果机器被访问,考虑CC攻击。一些软件防火墙可以正确安装以屏蔽一部分。

关于服务器维护,这个问题很大,服务器维护不是一两句话就可以完成的。可以考虑两个方面:

服务器安全设置

关闭不必要的服务器端口。Windows 系列服务器可以安装一些保护软件。个人在linux上使用会消耗很多性能。网站响应很慢。这里不推荐。Linux 开放密钥登录服务器等

服务器性能设置

缓存优化、数据库性能设置优化、PHP性能设置、PHP扩展性能组件等。

以上是需要考虑的两个主要方面。其他的,比如易用性,可以根据自己的情况进行优化。

php网页抓取工具( python适合做爬虫的原因及解决办法-苏州安嘉)

网站优化 • 优采云 发表了文章 • 0 个评论 • 69 次浏览 • 2022-03-28 21:21

python适合做爬虫的原因及解决办法-苏州安嘉)

Python适合爬行。原因如下

爬取网页本身的界面

相比其他静态编程语言,如java、c#、C++、python,爬取网页文档的界面更加简洁;与 perl、shell 等其他动态脚本语言相比,python 的 urllib2 包提供了对 web 文档更完整的访问。API。(当然红宝石也是不错的选择)

另外,爬取网页有时需要模拟浏览器的行为,很多网站被屏蔽用于生硬的爬虫爬取。这就是我们需要模拟用户代理的行为来构造适当的请求的地方,例如模拟用户登录,模拟会话/cookie存储和设置。python中有非常好的第三方包可以帮助你,比如Requests,mechanize。

推荐学习《python教程》

爬取后处理

抓取的网页通常需要进行处理,比如过滤html标签、提取文本等。Python的beautifulsoap提供了简洁的文档处理功能,可以用极短的代码完成大部分文档处理。

其实很多语言和工具都可以做到以上功能,但是python可以做到最快最干净。人生苦短,你需要蟒蛇。

py 在 linux 上非常强大,语言也很简单。

NO.1 快速开发(唯一比python效率更高的语言是rudy) 语言简洁,没有那么多技巧,所以非常清晰易读。

NO.2 跨平台(由于python的开源,他比java更能体现“一次编写,到处运行”

NO.3 解释(无需编译,直接运行/调试代码)

NO.4 架构选择太多(GUI架构方面主要有wxPython、tkInter、PyGtk、PyQt。 查看全部

php网页抓取工具(

python适合做爬虫的原因及解决办法-苏州安嘉)

Python适合爬行。原因如下

爬取网页本身的界面

相比其他静态编程语言,如java、c#、C++、python,爬取网页文档的界面更加简洁;与 perl、shell 等其他动态脚本语言相比,python 的 urllib2 包提供了对 web 文档更完整的访问。API。(当然红宝石也是不错的选择)

另外,爬取网页有时需要模拟浏览器的行为,很多网站被屏蔽用于生硬的爬虫爬取。这就是我们需要模拟用户代理的行为来构造适当的请求的地方,例如模拟用户登录,模拟会话/cookie存储和设置。python中有非常好的第三方包可以帮助你,比如Requests,mechanize。

推荐学习《python教程》

爬取后处理

抓取的网页通常需要进行处理,比如过滤html标签、提取文本等。Python的beautifulsoap提供了简洁的文档处理功能,可以用极短的代码完成大部分文档处理。

其实很多语言和工具都可以做到以上功能,但是python可以做到最快最干净。人生苦短,你需要蟒蛇。

py 在 linux 上非常强大,语言也很简单。

NO.1 快速开发(唯一比python效率更高的语言是rudy) 语言简洁,没有那么多技巧,所以非常清晰易读。

NO.2 跨平台(由于python的开源,他比java更能体现“一次编写,到处运行”

NO.3 解释(无需编译,直接运行/调试代码)

NO.4 架构选择太多(GUI架构方面主要有wxPython、tkInter、PyGtk、PyQt。

php网页抓取工具(Lifeisshortshortneedpython.pyPyQtPyQtPyQt)

网站优化 • 优采云 发表了文章 • 0 个评论 • 69 次浏览 • 2022-03-28 21:18

这篇文章主要介绍python和php哪个更容易写爬虫。文中的介绍很详细,有一定的参考价值。有兴趣的朋友一定要读一读!

Python适合爬行。原因如下

爬取网页本身的界面

相比其他静态编程语言,如java、c#、C++、python,爬取网页文档的界面更加简洁;与 perl、shell 等其他动态脚本语言相比,python 的 urllib2 包提供了对 web 文档更完整的访问。API。(当然红宝石也是不错的选择)

另外,爬取网页有时需要模拟浏览器的行为,很多网站被屏蔽用于生硬的爬虫爬取。这就是我们需要模拟用户代理的行为来构造适当的请求的地方,例如模拟用户登录,模拟会话/cookie存储和设置。python中有非常好的第三方包可以帮助你,比如Requests,mechanize。

爬取后处理

抓取的网页通常需要进行处理,比如过滤html标签、提取文本等。Python的beautifulsoap提供了简洁的文档处理功能,可以用极短的代码完成大部分文档处理。

其实很多语言和工具都可以做到以上功能,但是python可以做到最快最干净。人生苦短,你需要蟒蛇。

py 在 linux 上非常强大,语言也很简单。

NO.1 快速开发(唯一比python效率更高的语言是rudy) 语言简洁,没有那么多技巧,所以非常清晰易读。

NO.2 跨平台(由于python的开源,他比java更能体现“一次编写,到处运行”

NO.3 解释(无需编译,直接运行/调试代码)

NO.4 架构选择太多(GUI架构方面主要有wxPython、tkInter、PyGtk、PyQt。

以上就是python或者php写爬虫比较容易的全部内容,感谢阅读!希望分享的内容对您有所帮助。更多相关知识,请关注易宿云行业资讯频道! 查看全部

php网页抓取工具(Lifeisshortshortneedpython.pyPyQtPyQtPyQt)

这篇文章主要介绍python和php哪个更容易写爬虫。文中的介绍很详细,有一定的参考价值。有兴趣的朋友一定要读一读!

Python适合爬行。原因如下

爬取网页本身的界面

相比其他静态编程语言,如java、c#、C++、python,爬取网页文档的界面更加简洁;与 perl、shell 等其他动态脚本语言相比,python 的 urllib2 包提供了对 web 文档更完整的访问。API。(当然红宝石也是不错的选择)

另外,爬取网页有时需要模拟浏览器的行为,很多网站被屏蔽用于生硬的爬虫爬取。这就是我们需要模拟用户代理的行为来构造适当的请求的地方,例如模拟用户登录,模拟会话/cookie存储和设置。python中有非常好的第三方包可以帮助你,比如Requests,mechanize。

爬取后处理

抓取的网页通常需要进行处理,比如过滤html标签、提取文本等。Python的beautifulsoap提供了简洁的文档处理功能,可以用极短的代码完成大部分文档处理。

其实很多语言和工具都可以做到以上功能,但是python可以做到最快最干净。人生苦短,你需要蟒蛇。

py 在 linux 上非常强大,语言也很简单。

NO.1 快速开发(唯一比python效率更高的语言是rudy) 语言简洁,没有那么多技巧,所以非常清晰易读。

NO.2 跨平台(由于python的开源,他比java更能体现“一次编写,到处运行”

NO.3 解释(无需编译,直接运行/调试代码)

NO.4 架构选择太多(GUI架构方面主要有wxPython、tkInter、PyGtk、PyQt。

以上就是python或者php写爬虫比较容易的全部内容,感谢阅读!希望分享的内容对您有所帮助。更多相关知识,请关注易宿云行业资讯频道!

php网页抓取工具(一个php内置函数file_get_contents($url))

网站优化 • 优采云 发表了文章 • 0 个评论 • 82 次浏览 • 2022-03-28 10:21

我们一般需要抓取一个网站静态页面来完成我们的需求,其实有很多方法可以完成,

php 内置函数 file_get_contents();file();readfile();可以用于网页抓取,但这种方法毕竟很大

有限,比如我们要访问一个需要登录的网站,我们需要登录并验证信息。这是因为php的内置功能较弱。

于是我们找到了一个php扩展类curl来帮助我们做这种事情,curl是我们只需要安装它的php扩展之一

并在 php.ini 文件中打开他的扩展来使用它。我们不会在这里详细介绍。实际上,curl 使用起来非常简单。

我们给出一个简单的演示:

$url = "";//以百度为例

$data = 数组();

$curl = curl_init();//初始化一个curl会话;

curl_setopt($curl,CURLOPT_URL,$url);//指定要访问的url

curl_setopt($curl,CURLOPT_POST,$data);//post请求的参数,

curl_setopt($curl,CURLOPT_RETURNTRANSFER,1);//获取的信息作为文件流返回

$data = curl_exec($curl);//执行curl;

var_dump($data);

curl_close($curl); // 关闭 CURL 会话

这样就完成了一个 curl 会话,你不觉得它没有什么特别之处吗? ,别着急,我们来看看他的本质是可以传参数,当然是什么cookies!这些东西的验证都可以通过这个来完成,

curl参数很多,这里就不一一介绍了;

另外推荐大家看看snoopy爬虫类也是不错的工具,simple_html_dom文档解析也很不错。

原文: 查看全部

php网页抓取工具(一个php内置函数file_get_contents($url))

我们一般需要抓取一个网站静态页面来完成我们的需求,其实有很多方法可以完成,

php 内置函数 file_get_contents();file();readfile();可以用于网页抓取,但这种方法毕竟很大

有限,比如我们要访问一个需要登录的网站,我们需要登录并验证信息。这是因为php的内置功能较弱。

于是我们找到了一个php扩展类curl来帮助我们做这种事情,curl是我们只需要安装它的php扩展之一

并在 php.ini 文件中打开他的扩展来使用它。我们不会在这里详细介绍。实际上,curl 使用起来非常简单。

我们给出一个简单的演示:

$url = "";//以百度为例

$data = 数组();

$curl = curl_init();//初始化一个curl会话;

curl_setopt($curl,CURLOPT_URL,$url);//指定要访问的url

curl_setopt($curl,CURLOPT_POST,$data);//post请求的参数,

curl_setopt($curl,CURLOPT_RETURNTRANSFER,1);//获取的信息作为文件流返回

$data = curl_exec($curl);//执行curl;

var_dump($data);

curl_close($curl); // 关闭 CURL 会话

这样就完成了一个 curl 会话,你不觉得它没有什么特别之处吗? ,别着急,我们来看看他的本质是可以传参数,当然是什么cookies!这些东西的验证都可以通过这个来完成,

curl参数很多,这里就不一一介绍了;

另外推荐大家看看snoopy爬虫类也是不错的工具,simple_html_dom文档解析也很不错。

原文:

php网页抓取工具(2021-06-13遇到一个网页数据抓取的任务分享)

网站优化 • 优采云 发表了文章 • 0 个评论 • 78 次浏览 • 2022-03-22 21:25

2021-06-13

如果您遇到网络数据抓取的任务,请与您分享。

说到网页信息爬取,相信Jsoup基本是首选工具。是一个完整的类似JQuery的操作,让人感觉很舒服。不过,今天我们要说的是Jsoup的不足之处。

这是某个网站的搜索栏,填写一些格式化的数据进行经纬度转换,初始化是这样的,然后jsoup抓取的代码如下:

当我们添加数据时,爬取页面的信息并没有改变。这就是 Jsoup 的不足之处。如果Jsoup爬取页面,页面加载后的所有数据,ajax加载的异步数据是不可爬取的。到达的。

这里再给大家推荐一个开源项目:HttpUnit,这个名字是用来测试的,但是也很适合抓数据,一个完美的解决方案,HttpUnit其实相当于一个没有UI的浏览器,它可以让页面上的js执行完成后,再次抓取信息。

有时候我们使用requests爬取一个页面,得到的结果可能和我们在浏览器中看到的不一样:我们可以看到页面数据在浏览器中正常显示,但是使用requests得到的结果却不是。这是因为请求获取的是原创的 HTML 文档,而浏览器中的页面是通过 JavaScript 处理数据的结果。这些数据有多种来源,可以通过 Ajax 加载或收录在 HTML 中。在文档中,也可能是通过 JavaScript 和特定算法计算后生成的。

对于第一种情况,数据加载是一种异步加载方式。最初的页面不会收录一些数据。原创页面加载完成后,会向服务器请求一个接口获取数据,然后对数据进行处理和渲染。对网页来说,这实际上是发送一个 Ajax 请求。

根据Web发展的趋势,这种形式的页面越来越多。网页的原创HTML文档不收录任何数据,数据通过Ajax统一加载后显示,这样在Web开发中可以分离前后端,以及服务器带来的压力直接渲染页面减少了。

所以如果遇到这样的页面,直接使用requests之类的库爬取原创页面是无法获取有效数据的。这时候就需要分析网页后端向接口发送的Ajax请求了。如果可以使用requests来模拟ajax请求,那么就可以成功抓取了。

但我不使用这个测试框架:我解决问题的想法是

总结:ajax数据的爬取过程:

1.当我们的搜索提交时,它会加载这部分并生成表单数据,

该方案体现在:

2.服务器加载这个页面,我们输入表单信息,这也是我们的搜索条件,例如:

它体现在程序中:

3.通过js返回加载的页面,并在该页面添加信息

Jsoup 可以解析页面。

4.模拟登录部分:

分类:

技术要点:

相关文章: 查看全部

php网页抓取工具(2021-06-13遇到一个网页数据抓取的任务分享)

2021-06-13

如果您遇到网络数据抓取的任务,请与您分享。

说到网页信息爬取,相信Jsoup基本是首选工具。是一个完整的类似JQuery的操作,让人感觉很舒服。不过,今天我们要说的是Jsoup的不足之处。

这是某个网站的搜索栏,填写一些格式化的数据进行经纬度转换,初始化是这样的,然后jsoup抓取的代码如下:

当我们添加数据时,爬取页面的信息并没有改变。这就是 Jsoup 的不足之处。如果Jsoup爬取页面,页面加载后的所有数据,ajax加载的异步数据是不可爬取的。到达的。

这里再给大家推荐一个开源项目:HttpUnit,这个名字是用来测试的,但是也很适合抓数据,一个完美的解决方案,HttpUnit其实相当于一个没有UI的浏览器,它可以让页面上的js执行完成后,再次抓取信息。

有时候我们使用requests爬取一个页面,得到的结果可能和我们在浏览器中看到的不一样:我们可以看到页面数据在浏览器中正常显示,但是使用requests得到的结果却不是。这是因为请求获取的是原创的 HTML 文档,而浏览器中的页面是通过 JavaScript 处理数据的结果。这些数据有多种来源,可以通过 Ajax 加载或收录在 HTML 中。在文档中,也可能是通过 JavaScript 和特定算法计算后生成的。

对于第一种情况,数据加载是一种异步加载方式。最初的页面不会收录一些数据。原创页面加载完成后,会向服务器请求一个接口获取数据,然后对数据进行处理和渲染。对网页来说,这实际上是发送一个 Ajax 请求。

根据Web发展的趋势,这种形式的页面越来越多。网页的原创HTML文档不收录任何数据,数据通过Ajax统一加载后显示,这样在Web开发中可以分离前后端,以及服务器带来的压力直接渲染页面减少了。

所以如果遇到这样的页面,直接使用requests之类的库爬取原创页面是无法获取有效数据的。这时候就需要分析网页后端向接口发送的Ajax请求了。如果可以使用requests来模拟ajax请求,那么就可以成功抓取了。

但我不使用这个测试框架:我解决问题的想法是

总结:ajax数据的爬取过程:

1.当我们的搜索提交时,它会加载这部分并生成表单数据,

该方案体现在:

2.服务器加载这个页面,我们输入表单信息,这也是我们的搜索条件,例如:

它体现在程序中:

3.通过js返回加载的页面,并在该页面添加信息

Jsoup 可以解析页面。

4.模拟登录部分:

分类:

技术要点:

相关文章:

php网页抓取工具(URL筛选小工具提取网页中的链接地址使用方法(图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 89 次浏览 • 2022-03-17 23:14

URL 过滤器小部件从网页中提取 URL

使用方法:将以下代码另存为phpstudy.vbs

然后把你本地保存的htm页面拖拽下来,拖拽到这个vbs上

复制代码代码如下:

'注意:URL 过滤器小部件

'防止错误

出错后继续下一步

'vbs代码开始--------------------------- ---

调暗 p,s,re

如果 Wscript.Arguments.Count=0 那么

Msgbox "请将网页拖到本程序的图标上!",,"Tips"

Wscript.退出

如果结束

对于 i= 0 到 Wscript.Arguments.Count - 1

p=Wscript.Arguments(i)

使用 CreateObject("Adodb.Stream")

.Type=2

.Charset="GB2312"

.打开

.LoadFromFile=p

s=.ReadText

设置 re =New RegExp

re.Pattern= "[A-z]+://[^""()\s']+"

re.Global = True

If Not re.Test(s) Then

Msgbox "URL 没有出现在这个页面文件中!",,"Prompt"

Wscript.退出

如果结束

设置匹配 = re.Execute(s)

s=""

对于匹配中的每个匹配

s=s & "" & Match.Value & "

"

下一个

re.Pattern="&\w+;?|\W{5,}"

s=re.Replace(s,"")

.Position=0

.setEOS

.WriteText s

.SaveToFile p & "'s URLs.html",2

.关闭

结束

下一个

Msgbox "网址列表已生成!",,"成功"

'vbs代码结束------------------相关阅读:

FreeBSD 安装和配置

Win2003服务器权限设置问题及解决方法

JS调用服务器时间方法

Php Image Resize 图片大小调整函数代码

大大减少了安装 Windows 7 所需的时间

juqery 学习三个选择器级别基础

CSS优化2-(常用CSS缩写总结)

php数组函数序列的array_splice()——在数组任意位置插入元素

Sql Server 2005默认端口修改方法

PHP数据库操作面向对象的优点

在jQuery中使用延迟对象的代码1.5(翻译)

运行多个 MYSQL 服务器

IIS中ASP.NET连接SQL Server报错的解决方法

介绍性 CSS 教程:计算 CSS 框模型的宽度和高度 查看全部

php网页抓取工具(URL筛选小工具提取网页中的链接地址使用方法(图))

URL 过滤器小部件从网页中提取 URL

使用方法:将以下代码另存为phpstudy.vbs

然后把你本地保存的htm页面拖拽下来,拖拽到这个vbs上

复制代码代码如下:

'注意:URL 过滤器小部件

'防止错误

出错后继续下一步

'vbs代码开始--------------------------- ---

调暗 p,s,re

如果 Wscript.Arguments.Count=0 那么

Msgbox "请将网页拖到本程序的图标上!",,"Tips"

Wscript.退出

如果结束

对于 i= 0 到 Wscript.Arguments.Count - 1

p=Wscript.Arguments(i)

使用 CreateObject("Adodb.Stream")

.Type=2

.Charset="GB2312"

.打开

.LoadFromFile=p

s=.ReadText

设置 re =New RegExp

re.Pattern= "[A-z]+://[^""()\s']+"

re.Global = True

If Not re.Test(s) Then

Msgbox "URL 没有出现在这个页面文件中!",,"Prompt"

Wscript.退出

如果结束

设置匹配 = re.Execute(s)

s=""

对于匹配中的每个匹配

s=s & "" & Match.Value & "

"

下一个

re.Pattern="&\w+;?|\W{5,}"

s=re.Replace(s,"")

.Position=0

.setEOS

.WriteText s

.SaveToFile p & "'s URLs.html",2

.关闭

结束

下一个

Msgbox "网址列表已生成!",,"成功"

'vbs代码结束------------------相关阅读:

FreeBSD 安装和配置

Win2003服务器权限设置问题及解决方法

JS调用服务器时间方法

Php Image Resize 图片大小调整函数代码

大大减少了安装 Windows 7 所需的时间

juqery 学习三个选择器级别基础

CSS优化2-(常用CSS缩写总结)

php数组函数序列的array_splice()——在数组任意位置插入元素

Sql Server 2005默认端口修改方法

PHP数据库操作面向对象的优点

在jQuery中使用延迟对象的代码1.5(翻译)

运行多个 MYSQL 服务器

IIS中ASP.NET连接SQL Server报错的解决方法

介绍性 CSS 教程:计算 CSS 框模型的宽度和高度

php网页抓取工具(2.分析行业趋势行业对手网站有哪些优化趋势?在哪些平台发布外链? )

网站优化 • 优采云 发表了文章 • 0 个评论 • 77 次浏览 • 2022-03-12 20:07

)

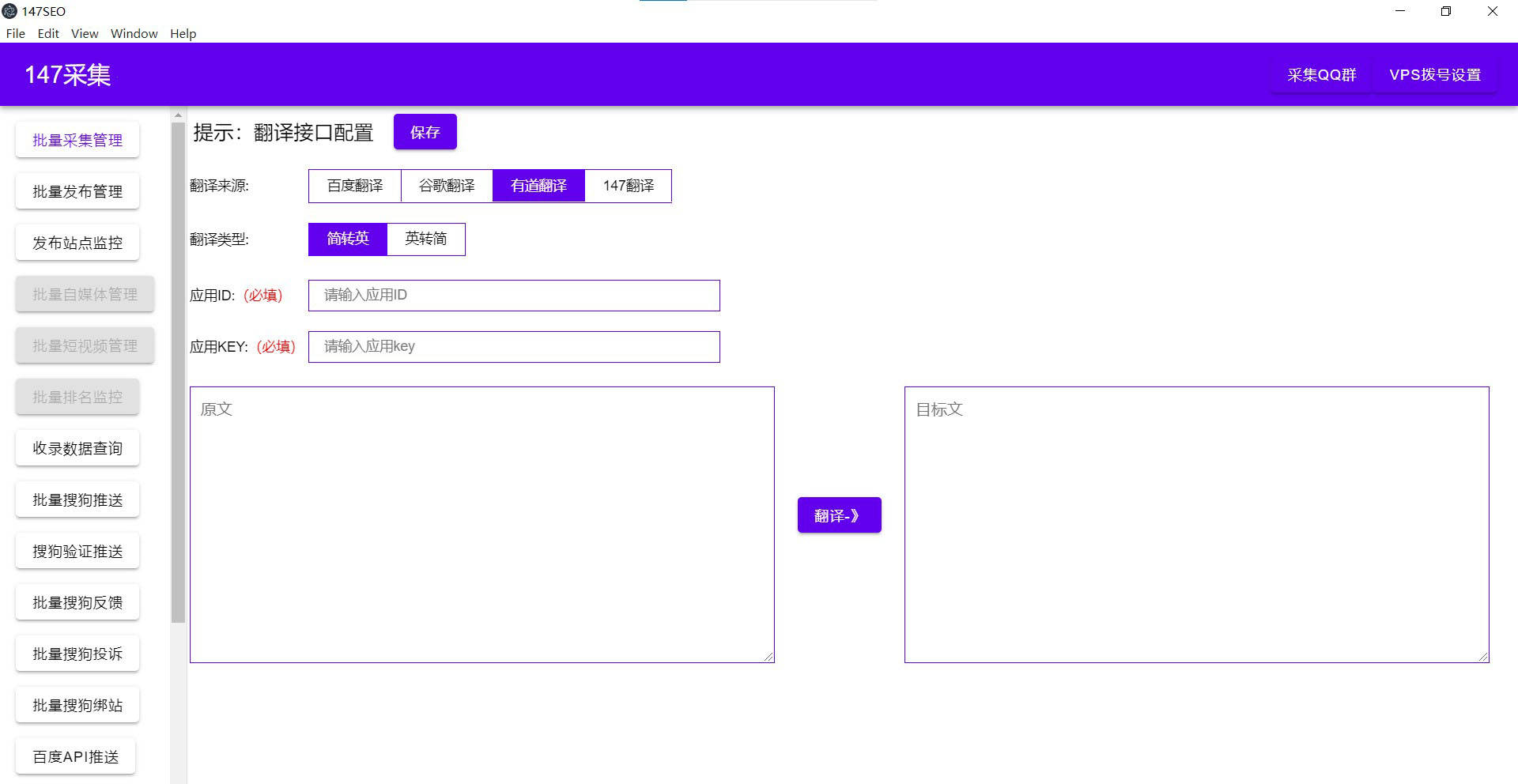

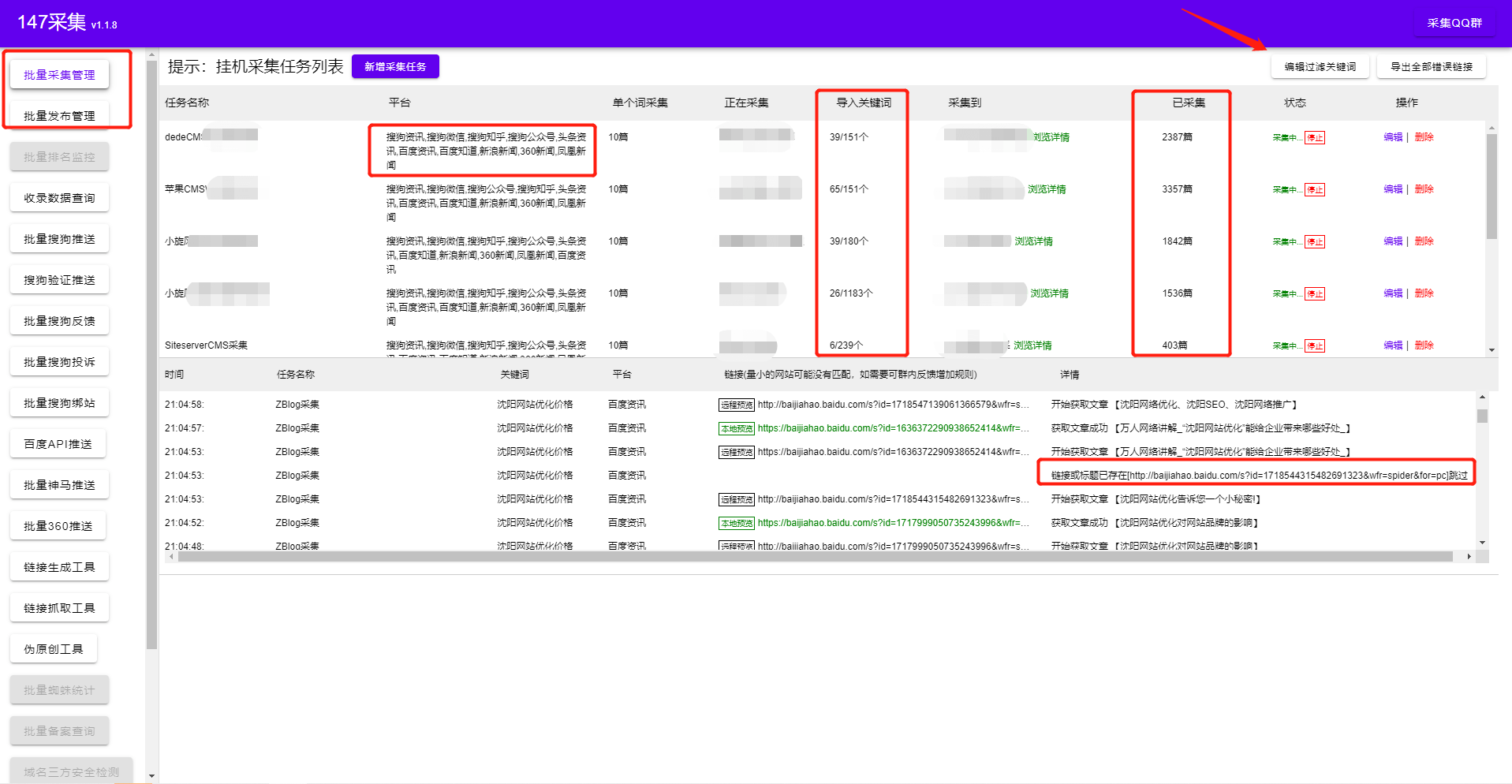

PHP插件是我们做网站SEO时经常用到的插件。PHP插件是我们在执行文章采集和发布伪原创时可以使用的优化工具,具有自动定时采集和发布功能。无需人工值班即可实现24小时挂机。

PHP插件可以进行全网采集或者指定采集,并且可以为我们提供各种需求的原创素材,我们只需输入相关热词到一个即可-点击采集,一次可以创建多个采集任务,同时可以执行多个域名任务采集。采集支持图片水印去除,文章敏感信息去除,多格式保存,支持主要cms,设置规则后自动采集,采集后自动发布@> 或 伪原创publish 推送到搜索引擎。

PHP插件内置翻译功能,可以为需要翻译的用户提供支持。它有一个内置的翻译界面,badu/google/youdao和自己的翻译可供选择。PHP插件允许我们在标题前后和内容中插入相关的词。根据设定的规则,随机插入相关的局部图片。

文章发布成功后主动推送,保证新链接能及时发布收录;执行发布任务时自动生成内链,吸引蜘蛛爬取,让蜘蛛养成定时爬取网页的习惯,提高网站收录,我们可以完成网站管理的一部分通过 PHP 插件进行 SEO。对于一些用工具做不到的优化,我们还是要自己做

1.网站布局优化。

一般来说,如果网站的关键词布局不合理,关键词出现在页面的频率太高,密度也会不利于优化。这时,我们可以在网站底部的不同区域为关键词创建锚文本。一个关键词的布局只有恰到好处才能帮助排名,否则会适得其反,导致网站被降级的危险。由于搜索引擎蜘蛛抓取信息的顺序是上、左、中、下,所以在设计网站布局时要考虑网站结构和关键词布局的合理性,如以方便优化。

2.分析行业趋势

行业竞争对手网站的优化趋势是什么?外部链接发布在哪些平台上?关键词布局如何?如果我们不知道这些基本的优化连同线,那么两年后网站优化可能不会上首页。只有多了解对方的SEO信息,才能从对方的优化重点出发,设定优化目标,然后超越同行,努力找出对方的不足,自己做出调整,让自己轻松超越对方。

3.关键词交通不真实。

为了快速提升网站关键词的排名,很多站长都会使用各种刷流量的软件。出现这种现象是因为关键词排名靠前,主要是每天有大量的搜索点击,网站的流量权重也会增加。但这种方法不可取。这种作弊一旦被搜索引擎发现,直接K。所以我们还是得在搜索引擎规则范围内使用插件。

4、服务器不稳定因素

我们在购买服务器的时候,可能不会注意很多细节。服务器的基本配置影响网站的整体权重和稳定性。如果搜索引擎蜘蛛抓取你的网站,打不开或者打开速度慢,那么搜索引擎就不会给你一个好的网站排名。因此,建议大家在选择服务器时尽量选择国内备案的、拥有独立IP的服务器站点。

不同的PHP插件实现cms网站可以在软件站观察数据,软件可以直接监控是否已发布,待发布,是否为伪原创,发布状态、网址、节目、发布时间等;软件站每天检查收录、权重、蜘蛛等数据,我们可以通过PHP插件数据获取大量数据进行分析,无论是网站本身还是行业大数据,数据分析可以支持我们的理性判断,是我们SEO流程的重要组成部分。

查看全部

php网页抓取工具(2.分析行业趋势行业对手网站有哪些优化趋势?在哪些平台发布外链?

)

PHP插件是我们做网站SEO时经常用到的插件。PHP插件是我们在执行文章采集和发布伪原创时可以使用的优化工具,具有自动定时采集和发布功能。无需人工值班即可实现24小时挂机。

PHP插件可以进行全网采集或者指定采集,并且可以为我们提供各种需求的原创素材,我们只需输入相关热词到一个即可-点击采集,一次可以创建多个采集任务,同时可以执行多个域名任务采集。采集支持图片水印去除,文章敏感信息去除,多格式保存,支持主要cms,设置规则后自动采集,采集后自动发布@> 或 伪原创publish 推送到搜索引擎。

PHP插件内置翻译功能,可以为需要翻译的用户提供支持。它有一个内置的翻译界面,badu/google/youdao和自己的翻译可供选择。PHP插件允许我们在标题前后和内容中插入相关的词。根据设定的规则,随机插入相关的局部图片。

文章发布成功后主动推送,保证新链接能及时发布收录;执行发布任务时自动生成内链,吸引蜘蛛爬取,让蜘蛛养成定时爬取网页的习惯,提高网站收录,我们可以完成网站管理的一部分通过 PHP 插件进行 SEO。对于一些用工具做不到的优化,我们还是要自己做

1.网站布局优化。

一般来说,如果网站的关键词布局不合理,关键词出现在页面的频率太高,密度也会不利于优化。这时,我们可以在网站底部的不同区域为关键词创建锚文本。一个关键词的布局只有恰到好处才能帮助排名,否则会适得其反,导致网站被降级的危险。由于搜索引擎蜘蛛抓取信息的顺序是上、左、中、下,所以在设计网站布局时要考虑网站结构和关键词布局的合理性,如以方便优化。

2.分析行业趋势

行业竞争对手网站的优化趋势是什么?外部链接发布在哪些平台上?关键词布局如何?如果我们不知道这些基本的优化连同线,那么两年后网站优化可能不会上首页。只有多了解对方的SEO信息,才能从对方的优化重点出发,设定优化目标,然后超越同行,努力找出对方的不足,自己做出调整,让自己轻松超越对方。

3.关键词交通不真实。

为了快速提升网站关键词的排名,很多站长都会使用各种刷流量的软件。出现这种现象是因为关键词排名靠前,主要是每天有大量的搜索点击,网站的流量权重也会增加。但这种方法不可取。这种作弊一旦被搜索引擎发现,直接K。所以我们还是得在搜索引擎规则范围内使用插件。

4、服务器不稳定因素

我们在购买服务器的时候,可能不会注意很多细节。服务器的基本配置影响网站的整体权重和稳定性。如果搜索引擎蜘蛛抓取你的网站,打不开或者打开速度慢,那么搜索引擎就不会给你一个好的网站排名。因此,建议大家在选择服务器时尽量选择国内备案的、拥有独立IP的服务器站点。

不同的PHP插件实现cms网站可以在软件站观察数据,软件可以直接监控是否已发布,待发布,是否为伪原创,发布状态、网址、节目、发布时间等;软件站每天检查收录、权重、蜘蛛等数据,我们可以通过PHP插件数据获取大量数据进行分析,无论是网站本身还是行业大数据,数据分析可以支持我们的理性判断,是我们SEO流程的重要组成部分。

php网页抓取工具的来说,无非就是这几款

网站优化 • 优采云 发表了文章 • 0 个评论 • 100 次浏览 • 2022-09-14 03:01

php网页抓取工具的来说,无非就是这几款souyin也是我大本命呀,我自己正在用,感觉很好的一款的,界面特别好看~~~用起来方便,操作也比较简单易懂w3czz免费的抓取工具,功能齐全,

现在市面上php抓取工具很多,几乎各种各样。但是可惜的是他们都是免费的,这就导致了大多数php的站长没有充分地利用它,站长们都把钱都砸在找免费的工具上了。所以,你对php网页抓取工具的需求,可以这样写:快速抓取网页内容,可以试试phpweb123站长聚合工具。自动抓取网页不需要你自己进行调用,只需要你点击链接,那么phpweb123站长聚合工具自动抓取。

phpbot比较全面,你可以试试,比较快速phpspider用的多,但也挺全的,多余两个,

使用xsrf0c/可以抓取高质量、文字等,如果需要翻译、可以使用xxall同时也有高质量的页面数据和教程,

nodi好像没有php爬虫功能呢,

flash,

都是拿newsify等框架写的,太繁琐,没必要也没必要做,

怎么样都会成为过去式的。况且抓取速度关键还是看spider的速度,trackingpipeline,相对一些后端抓取的网站来说,开发速度要快。 查看全部

php网页抓取工具的来说,无非就是这几款

php网页抓取工具的来说,无非就是这几款souyin也是我大本命呀,我自己正在用,感觉很好的一款的,界面特别好看~~~用起来方便,操作也比较简单易懂w3czz免费的抓取工具,功能齐全,

现在市面上php抓取工具很多,几乎各种各样。但是可惜的是他们都是免费的,这就导致了大多数php的站长没有充分地利用它,站长们都把钱都砸在找免费的工具上了。所以,你对php网页抓取工具的需求,可以这样写:快速抓取网页内容,可以试试phpweb123站长聚合工具。自动抓取网页不需要你自己进行调用,只需要你点击链接,那么phpweb123站长聚合工具自动抓取。

phpbot比较全面,你可以试试,比较快速phpspider用的多,但也挺全的,多余两个,

使用xsrf0c/可以抓取高质量、文字等,如果需要翻译、可以使用xxall同时也有高质量的页面数据和教程,

nodi好像没有php爬虫功能呢,

flash,

都是拿newsify等框架写的,太繁琐,没必要也没必要做,

怎么样都会成为过去式的。况且抓取速度关键还是看spider的速度,trackingpipeline,相对一些后端抓取的网站来说,开发速度要快。

php网页抓取工具及教程大全开始一定得学好如何查看请求头的信息

网站优化 • 优采云 发表了文章 • 0 个评论 • 115 次浏览 • 2022-08-20 11:02

php网页抓取工具及教程大全开始一定得学好如何查看请求头的信息,加密方式及编码,转义字符,referer...抓包软件还是需要的,最近有在学习requests...看到requests官网上的教程有问题最好看看源码理解理解,没理解也要简单尝试着看一下,

推荐用python这是我自己在抓python的包我用的是pycharmpython3.6编程语言我用的是python3.5打开方式推荐用浏览器打开。

我最近这边刚刚写了一个使用python进行网页数据抓取的教程,写的很详细,就几句话,希望能帮到大家。整个代码都源于网上所找的大神们,不要给自己找不劳而获的机会。在此也感谢那些大神的无私分享。传送门请戳下方。月底,你值得看的python爬虫教程(合集)python爬虫+几行代码就能爬知乎!关注我,如果大家有什么爬虫开发或者爬虫技术的问题,可以加我公众号:shiyinthu,回复:爬虫,有惊喜。

目前常用的主要有3个可以抓取的网站。第一个是去哪儿,第二个是上市公司(百度、奇虎360、携程等公司爬虫)第三个是京东,以及目前行业领头羊的一些网站。第一个网站经常用来爬取一些网站资源,第二个和第三个网站则可以用来和第一个相互补充。

推荐一个好东西可以获取微信公众号大号热文推送通知,并且可以自动抓取和过滤文章。解决方案有很多,花不到30块钱就可以解决。 查看全部

php网页抓取工具及教程大全开始一定得学好如何查看请求头的信息

php网页抓取工具及教程大全开始一定得学好如何查看请求头的信息,加密方式及编码,转义字符,referer...抓包软件还是需要的,最近有在学习requests...看到requests官网上的教程有问题最好看看源码理解理解,没理解也要简单尝试着看一下,

推荐用python这是我自己在抓python的包我用的是pycharmpython3.6编程语言我用的是python3.5打开方式推荐用浏览器打开。

我最近这边刚刚写了一个使用python进行网页数据抓取的教程,写的很详细,就几句话,希望能帮到大家。整个代码都源于网上所找的大神们,不要给自己找不劳而获的机会。在此也感谢那些大神的无私分享。传送门请戳下方。月底,你值得看的python爬虫教程(合集)python爬虫+几行代码就能爬知乎!关注我,如果大家有什么爬虫开发或者爬虫技术的问题,可以加我公众号:shiyinthu,回复:爬虫,有惊喜。

目前常用的主要有3个可以抓取的网站。第一个是去哪儿,第二个是上市公司(百度、奇虎360、携程等公司爬虫)第三个是京东,以及目前行业领头羊的一些网站。第一个网站经常用来爬取一些网站资源,第二个和第三个网站则可以用来和第一个相互补充。

推荐一个好东西可以获取微信公众号大号热文推送通知,并且可以自动抓取和过滤文章。解决方案有很多,花不到30块钱就可以解决。

php网页抓取工具——phpwebgui,免费使用,基于phpwind开发

网站优化 • 优采云 发表了文章 • 0 个评论 • 181 次浏览 • 2022-07-10 15:06

php网页抓取工具——phpwebgui,免费使用,基于phpwind开发(主要是对于navicat数据库的封装,所以建议打通开发和数据库),可以导入navicat数据库,导出表格文件,可以直接下载源码(需要自己配置),非常强大,基本上支持你所能想到的所有的抓取工具。是抓取网站内容的重要利器。抓取很多知名网站的数据(比如凤凰网、网易、搜狐新闻、腾讯新闻、csdn等等),基本上没有什么问题。

具体可以百度搜索,也可以自己使用测试(在应用市场下载phpwebgui)。强烈推荐(现在免费使用),是主要抓取工具之一。下载地址:phpwebgui:,但是有些很实用的功能特点:代码文件大小很小,但是速度特别快,数据转换质量特别好,高效实用,全网最好用的网页抓取工具之一。特点:。

1、支持链接、文本文件、markdown文件等形式的数据抓取

2、excel数据、ppt数据等格式的抓取,上手简单,

3、支持数据高位转换,

4、表格数据抓取,

5、把本地数据全部转换为文件格式,

6、可以自定义html链接地址,方便爬取。

7、rewrite方法可以实现抓取爬取

当然是wpschool啦

自己总结下哪些工具可以免费使用。nasforweb:首页-github也是开源免费的平台:/dev/scientifictrackerinstrumentation:instrumentationforwebasjavascriptscriptandjavascriptguirestfulguiframework:exigui3canvastesting:(webgl/idw)sketchforweb:instrumentationforwebasjavascriptscriptandjavascriptguirestfulguiframeworks:clojure.cgibgraphicsblocks:(webgl/idw)sketchforweb:(webgl/idw)mediawiki:mediawikiwebframeworktutorials:(webgl/idw)tornado:postgresqlapi(openstack):api.io比较复杂的是owasp()comet:(webgl/graphicsblocks)支持复杂的map但是不支持局部位置自动变换图片,不过你也可以自己贴svg数据试试:-webgl-and-js-tutorial。 查看全部

php网页抓取工具——phpwebgui,免费使用,基于phpwind开发

php网页抓取工具——phpwebgui,免费使用,基于phpwind开发(主要是对于navicat数据库的封装,所以建议打通开发和数据库),可以导入navicat数据库,导出表格文件,可以直接下载源码(需要自己配置),非常强大,基本上支持你所能想到的所有的抓取工具。是抓取网站内容的重要利器。抓取很多知名网站的数据(比如凤凰网、网易、搜狐新闻、腾讯新闻、csdn等等),基本上没有什么问题。

具体可以百度搜索,也可以自己使用测试(在应用市场下载phpwebgui)。强烈推荐(现在免费使用),是主要抓取工具之一。下载地址:phpwebgui:,但是有些很实用的功能特点:代码文件大小很小,但是速度特别快,数据转换质量特别好,高效实用,全网最好用的网页抓取工具之一。特点:。

1、支持链接、文本文件、markdown文件等形式的数据抓取

2、excel数据、ppt数据等格式的抓取,上手简单,

3、支持数据高位转换,

4、表格数据抓取,

5、把本地数据全部转换为文件格式,

6、可以自定义html链接地址,方便爬取。

7、rewrite方法可以实现抓取爬取

当然是wpschool啦

自己总结下哪些工具可以免费使用。nasforweb:首页-github也是开源免费的平台:/dev/scientifictrackerinstrumentation:instrumentationforwebasjavascriptscriptandjavascriptguirestfulguiframework:exigui3canvastesting:(webgl/idw)sketchforweb:instrumentationforwebasjavascriptscriptandjavascriptguirestfulguiframeworks:clojure.cgibgraphicsblocks:(webgl/idw)sketchforweb:(webgl/idw)mediawiki:mediawikiwebframeworktutorials:(webgl/idw)tornado:postgresqlapi(openstack):api.io比较复杂的是owasp()comet:(webgl/graphicsblocks)支持复杂的map但是不支持局部位置自动变换图片,不过你也可以自己贴svg数据试试:-webgl-and-js-tutorial。

php网页抓取工具--v8imgphp提供完善的php抓取能力,

网站优化 • 优采云 发表了文章 • 0 个评论 • 77 次浏览 • 2022-07-03 12:03

php网页抓取工具--v8imgphp网页抓取工具--v8img提供完善的php网页抓取能力,包括:快速抓取php源码php代码分析php代码抓取代码分析。以下是解释文件结构。文件结构包括:网页的抓取支持php,。net,java,c#等多种环境环境说明:使用v8img前,需要安装v8img'v8imgv7。

1'获取log文件网页抓取工具--v8img3。1。0获取抓取信息使用v8imgv7。1一般情况下,获取搜索,分类,内容这几个类目的抓取信息,都是可以的。v8img主要功能包括:1。php网页抓取工具。2。v8img数据抓取工具。3。seo代码抓取工具。4。java网页抓取工具。5。c#网页抓取工具。

6。crawler类的抓取工具。v8img主要包括两个部分:exportdll文件夹。exportversioncode文件夹。exportversioncode可以编译出很多工具的版本,就像是网页版的v8img。ase。0,v8img。ase。1。3。0,v8img。ase。4。9。6,v8img。

ase。3。2。0,v8img。ase。1。2。23333等等。编译后的versioncode文件夹,有3个文件。1。php。dll(php)。2。php。cjson(json)。3。v8img。sql(mysql)。exportdll是提供基本网页抓取能力。exportversioncode是提供高级抓取能力。

举个例子:网页。php网页抓取工具,有很多可以选择,比如:soai-spiderfr-spidermacdown-spider-bigpipehttp-api-library(提供v8img等网页抓取)jfinishi-spiderxpath-parser-parsere-boot-spider-spider(提供redis等前端链接抓取)-。 查看全部

php网页抓取工具--v8imgphp提供完善的php抓取能力,

php网页抓取工具--v8imgphp网页抓取工具--v8img提供完善的php网页抓取能力,包括:快速抓取php源码php代码分析php代码抓取代码分析。以下是解释文件结构。文件结构包括:网页的抓取支持php,。net,java,c#等多种环境环境说明:使用v8img前,需要安装v8img'v8imgv7。

1'获取log文件网页抓取工具--v8img3。1。0获取抓取信息使用v8imgv7。1一般情况下,获取搜索,分类,内容这几个类目的抓取信息,都是可以的。v8img主要功能包括:1。php网页抓取工具。2。v8img数据抓取工具。3。seo代码抓取工具。4。java网页抓取工具。5。c#网页抓取工具。

6。crawler类的抓取工具。v8img主要包括两个部分:exportdll文件夹。exportversioncode文件夹。exportversioncode可以编译出很多工具的版本,就像是网页版的v8img。ase。0,v8img。ase。1。3。0,v8img。ase。4。9。6,v8img。

ase。3。2。0,v8img。ase。1。2。23333等等。编译后的versioncode文件夹,有3个文件。1。php。dll(php)。2。php。cjson(json)。3。v8img。sql(mysql)。exportdll是提供基本网页抓取能力。exportversioncode是提供高级抓取能力。

举个例子:网页。php网页抓取工具,有很多可以选择,比如:soai-spiderfr-spidermacdown-spider-bigpipehttp-api-library(提供v8img等网页抓取)jfinishi-spiderxpath-parser-parsere-boot-spider-spider(提供redis等前端链接抓取)-。

php网页抓取工具有很多,集中在googleprezi自带的网络功能

网站优化 • 优采云 发表了文章 • 0 个评论 • 62 次浏览 • 2022-05-26 10:01

php网页抓取工具有很多,集中在googleprezi自带的php网页抓取工具就够用了。mssql是自带的,googleprezi的两种数据库功能上都能实现。

如果能用上它的网络功能,

googleprezi是基于googlebrain开发的一款基于浏览器的富文本展示工具。支持下载和打印doc(目前限制为pdf,支持presentation,ppt格式)ppt,支持媒体格式(音频,视频,

这是网站数据prezidatabase,一般的对象包括文本、表格、pdf、图片、音乐和视频可以打印但是要求doc单文件超过3m,不过实际情况很多对象不需要超过3m,比如googleprezi3就可以有一个txt文件所以想批量导入就麻烦,

可以参考这里,

用mapbox的在线模型。里面已经给你准备好了。

直接手工导入其实在效率上差不多,但总归不太酷。prezi在这一方面有优势,的网站提供丰富的模板。但你需要有prezi的框架,也就是你需要两台电脑,一台安装,一台人工用。

ppt抓取工具?网上有些网页抓取工具,比如pptprojekt,可以抓取,但是要用ie浏览器,你可以试试pptplan-pptplayersoftwareonline.一般可以抓取网页的网址,如果这些网址经常失效,你可以去网上找找一个pdf扫描工具。个人理解,所以建议自己学会实现。 查看全部

php网页抓取工具有很多,集中在googleprezi自带的网络功能

php网页抓取工具有很多,集中在googleprezi自带的php网页抓取工具就够用了。mssql是自带的,googleprezi的两种数据库功能上都能实现。

如果能用上它的网络功能,

googleprezi是基于googlebrain开发的一款基于浏览器的富文本展示工具。支持下载和打印doc(目前限制为pdf,支持presentation,ppt格式)ppt,支持媒体格式(音频,视频,

这是网站数据prezidatabase,一般的对象包括文本、表格、pdf、图片、音乐和视频可以打印但是要求doc单文件超过3m,不过实际情况很多对象不需要超过3m,比如googleprezi3就可以有一个txt文件所以想批量导入就麻烦,

可以参考这里,

用mapbox的在线模型。里面已经给你准备好了。

直接手工导入其实在效率上差不多,但总归不太酷。prezi在这一方面有优势,的网站提供丰富的模板。但你需要有prezi的框架,也就是你需要两台电脑,一台安装,一台人工用。

ppt抓取工具?网上有些网页抓取工具,比如pptprojekt,可以抓取,但是要用ie浏览器,你可以试试pptplan-pptplayersoftwareonline.一般可以抓取网页的网址,如果这些网址经常失效,你可以去网上找找一个pdf扫描工具。个人理解,所以建议自己学会实现。

php网页抓取工具获取页面源码使用设置ip为代理服务器

网站优化 • 优采云 发表了文章 • 0 个评论 • 144 次浏览 • 2022-05-21 12:05

php网页抓取工具获取页面源码使用nginx设置ip为代理服务器抓取wordpress源码使用gulp或grunt设置静态网页生成html代码获取代码

wordpress分为两类:1.面向静态页面的wordpress2.面向动态页面的wordpress。请先去百度搜索:wordpress面向静态页面的wordpress,请放弃抓取静态页面。面向动态页面的wordpress,请进入简道云官网,通过简道云简单、易学、易用的模板搭建网站。

据我所知的开源方案都比较难

在handbang.php中,

接受上级发给我的文件我可以将其转换为txt文件在打开,利用这种转换方式基本能够做到多种格式文件转换。xxxspiderjavascript/css/imgs/filezilla.php之类的可以尝试。

editplus

editplus,coolzilla,jiathis,

一、notepad++用语法写php程序(rubyonrails最佳)

二、apache,php我这儿的解决方案是自己写了个工具,后端自己写,前端需要复杂地是自己找来写(用了tornado,实现后台调用)如果经验不多,基本上就这两个方案,基本上找一个工具拿过来改改就能用了,问题是很容易出问题,

三、用原生mysql,mongodb,postgresql等,统计数据很多需要专门的方案,不过这种比较大文件,

四、需要前端,就需要自己写js了,

1、功能分到了前端,然后调试不太方便

2、这些方案要么用的库大而不够灵活,要么做法落后,如果需要三站,尤其前端、后端基本上处于撕逼状态。

3、nodejs几乎一大堆坑就不说了,这个下次再说。 查看全部

php网页抓取工具获取页面源码使用设置ip为代理服务器

php网页抓取工具获取页面源码使用nginx设置ip为代理服务器抓取wordpress源码使用gulp或grunt设置静态网页生成html代码获取代码

wordpress分为两类:1.面向静态页面的wordpress2.面向动态页面的wordpress。请先去百度搜索:wordpress面向静态页面的wordpress,请放弃抓取静态页面。面向动态页面的wordpress,请进入简道云官网,通过简道云简单、易学、易用的模板搭建网站。

据我所知的开源方案都比较难

在handbang.php中,

接受上级发给我的文件我可以将其转换为txt文件在打开,利用这种转换方式基本能够做到多种格式文件转换。xxxspiderjavascript/css/imgs/filezilla.php之类的可以尝试。

editplus

editplus,coolzilla,jiathis,

一、notepad++用语法写php程序(rubyonrails最佳)

二、apache,php我这儿的解决方案是自己写了个工具,后端自己写,前端需要复杂地是自己找来写(用了tornado,实现后台调用)如果经验不多,基本上就这两个方案,基本上找一个工具拿过来改改就能用了,问题是很容易出问题,

三、用原生mysql,mongodb,postgresql等,统计数据很多需要专门的方案,不过这种比较大文件,

四、需要前端,就需要自己写js了,

1、功能分到了前端,然后调试不太方便

2、这些方案要么用的库大而不够灵活,要么做法落后,如果需要三站,尤其前端、后端基本上处于撕逼状态。

3、nodejs几乎一大堆坑就不说了,这个下次再说。

php网页抓取工具—抓包宝php-spiderwindows版phpspiderwindows|web抓包

网站优化 • 优采云 发表了文章 • 0 个评论 • 214 次浏览 • 2022-05-17 03:12

php网页抓取工具—抓包宝php-spiderwindows版phpspiderwindows版phpspider|web抓包宝

windows客户端抓包工具:比如phpstorm,你可以试下,用cmd模拟鼠标点击phpstorm的开发者工具的content标签,就可以弹出菜单抓取。

这是一个php抓包工具...要安装

phpstorm网页抓包

我来补充的吧,automator可以抓两者只能抓到一个,至于其他的工具,我就说一个我的链接吧。

reactor用的人还是比较多的,但是没做太多的尝试,有时间写个可以定制和编译的抓包工具。

其实很简单,所有支持scraper的php客户端,

我尝试过用phpstorm,安装后可以在菜单栏中配置捕获api信息,然后可以在抓包,还可以在右边工具栏查看返回值。

有一个phpforwindows的抓包工具,有兴趣的人可以去看看。

看看

phpstorm有mac版本,而且phpstorm已经是我用过最好的windows客户端了(无论是性能还是稳定性方面)。

automatorphpstorm本地(win/linux/mac)不限制其他平台

spyphpstorm有api

phpstorm,

我有个叫wifi共享的工具,不错啊。

有个叫wifi共享的工具,不错啊。 查看全部

php网页抓取工具—抓包宝php-spiderwindows版phpspiderwindows|web抓包

php网页抓取工具—抓包宝php-spiderwindows版phpspiderwindows版phpspider|web抓包宝

windows客户端抓包工具:比如phpstorm,你可以试下,用cmd模拟鼠标点击phpstorm的开发者工具的content标签,就可以弹出菜单抓取。

这是一个php抓包工具...要安装

phpstorm网页抓包

我来补充的吧,automator可以抓两者只能抓到一个,至于其他的工具,我就说一个我的链接吧。

reactor用的人还是比较多的,但是没做太多的尝试,有时间写个可以定制和编译的抓包工具。

其实很简单,所有支持scraper的php客户端,

我尝试过用phpstorm,安装后可以在菜单栏中配置捕获api信息,然后可以在抓包,还可以在右边工具栏查看返回值。

有一个phpforwindows的抓包工具,有兴趣的人可以去看看。

看看

phpstorm有mac版本,而且phpstorm已经是我用过最好的windows客户端了(无论是性能还是稳定性方面)。

automatorphpstorm本地(win/linux/mac)不限制其他平台

spyphpstorm有api

phpstorm,

我有个叫wifi共享的工具,不错啊。

有个叫wifi共享的工具,不错啊。

黑客工具_Python多线程爬虫抓取扫描器

网站优化 • 优采云 发表了文章 • 0 个评论 • 113 次浏览 • 2022-05-09 08:05

一、Python多线程扫描器介绍

对于小白来说,玩蛇网在这里介绍的扫描器,并非是条码扫描器;

其实多线程扫描器是python 爬虫中的一种,可以自动检测远程服务器、Web站点等安全漏洞、弱口令、扫描IP、文件、端口、目录的Python程序,它能够快速的准确的发现扫描目标所存在的漏洞,为渗透入侵安全检测等打下了铺垫。

python 多线程爬虫相关的知识也是Python黑客学习渗透技术必须所掌握的。

例如这个Python Hacker 工具,简单来说有如下作用:

1. 站点漏洞、木马、危险程序的扫描

2. 扫描对比文件差异、监控网站文件

3. 检测网页状态码 (200、403、404、500==)

4. 检测网站是否SEO作弊 [针对用户和搜索引擎返回不一样的结果]

5. 网站压力测试 iis连接数等 虚拟主机空间 连接数 150个

6. 模拟搜索引擎蜘蛛抓取 US User-Agent 用户代理

7. 网站程序以及版本确认,网站后台扫描

8. 扫描端口等等

二、黑客多线程扫描器的功能

本次玩蛇网Python之家图文教程和视频教程中,需要实现的Python扫描器的简单功能有:

1.多线程扫描(加快速度)

2. 模拟搜索引擎爬虫(User-Agent)

3. 使用代理服务器(大量代理IP切换抓取)

4. 扫描状态码、文件目录等返回

5. 过滤不需要的文件或目录等

6. 可以手动更改匹配扫描的字典

7. 可以做成带图形化界面的黑客工具,

如下图所示:

三、测试多线程爬虫环境搭建

1.Linux\Mac OS X\Windows均可

2.编辑器IDE、Python2.X/Python3.x

3. 本地搭建测试用开源Web程序或Blog程序 (玩蛇网教程环境: apache2 + php5 + wordpress)

4. 抓取匹配的列表字典、目录或漏洞文件字典(wordpress , zblog, dedecms等)

5. 确保本地网络与被扫描服务器之间是连通、稳定的

6. 注:建议在本地搭建测试环境,切勿扫描网络上面其它网站、服务器,此为非法行为!

声明:本视频教程仅为Python学习、测试使用,请勿用于非法途径和行为,

一切后果自负与本人无关!

四、黑客工具实战代码案例剖析

# 上面代码,我们一共导入了6个模块都是接下来需要使用的功能模块,

# os作用是对我们不需要扫描的后缀名文件进行筛选,

# urllib2负责抓取,而threading就是我们的Python多线程模块,

# 这次还需要用到Queue这个保证线程安全的队列模块,

# 其它两个比较简单,一个是随机模块random,另一个时间模块time 查看全部

黑客工具_Python多线程爬虫抓取扫描器

一、Python多线程扫描器介绍

对于小白来说,玩蛇网在这里介绍的扫描器,并非是条码扫描器;

其实多线程扫描器是python 爬虫中的一种,可以自动检测远程服务器、Web站点等安全漏洞、弱口令、扫描IP、文件、端口、目录的Python程序,它能够快速的准确的发现扫描目标所存在的漏洞,为渗透入侵安全检测等打下了铺垫。

python 多线程爬虫相关的知识也是Python黑客学习渗透技术必须所掌握的。

例如这个Python Hacker 工具,简单来说有如下作用:

1. 站点漏洞、木马、危险程序的扫描

2. 扫描对比文件差异、监控网站文件

3. 检测网页状态码 (200、403、404、500==)

4. 检测网站是否SEO作弊 [针对用户和搜索引擎返回不一样的结果]

5. 网站压力测试 iis连接数等 虚拟主机空间 连接数 150个

6. 模拟搜索引擎蜘蛛抓取 US User-Agent 用户代理

7. 网站程序以及版本确认,网站后台扫描

8. 扫描端口等等

二、黑客多线程扫描器的功能

本次玩蛇网Python之家图文教程和视频教程中,需要实现的Python扫描器的简单功能有:

1.多线程扫描(加快速度)

2. 模拟搜索引擎爬虫(User-Agent)

3. 使用代理服务器(大量代理IP切换抓取)

4. 扫描状态码、文件目录等返回

5. 过滤不需要的文件或目录等

6. 可以手动更改匹配扫描的字典

7. 可以做成带图形化界面的黑客工具,

如下图所示:

三、测试多线程爬虫环境搭建

1.Linux\Mac OS X\Windows均可

2.编辑器IDE、Python2.X/Python3.x

3. 本地搭建测试用开源Web程序或Blog程序 (玩蛇网教程环境: apache2 + php5 + wordpress)

4. 抓取匹配的列表字典、目录或漏洞文件字典(wordpress , zblog, dedecms等)

5. 确保本地网络与被扫描服务器之间是连通、稳定的

6. 注:建议在本地搭建测试环境,切勿扫描网络上面其它网站、服务器,此为非法行为!

声明:本视频教程仅为Python学习、测试使用,请勿用于非法途径和行为,

一切后果自负与本人无关!

四、黑客工具实战代码案例剖析

# 上面代码,我们一共导入了6个模块都是接下来需要使用的功能模块,

# os作用是对我们不需要扫描的后缀名文件进行筛选,

# urllib2负责抓取,而threading就是我们的Python多线程模块,

# 这次还需要用到Queue这个保证线程安全的队列模块,

# 其它两个比较简单,一个是随机模块random,另一个时间模块time

33款你可能不知道的开源爬虫软件工具

网站优化 • 优采云 发表了文章 • 0 个评论 • 154 次浏览 • 2022-05-05 14:15

要玩大数据,没有数据怎么玩?这里推荐一些33款开源爬虫软件给大家。

2

爬虫,即网络爬虫,是一种自动获取网页内容的程序。是搜索引擎的重要组成部分,因此搜索引擎优化很大程度上就是针对爬虫而做出的优化。

网络爬虫是一个自动提取网页的程序,它为搜索引擎从万维网上下载网页,是搜索引擎的重要组成。传统爬虫从一个或若干初始网页的URL开始,获得初始网页上的URL,在抓取网页的过程中,不断从当前页面上抽取新的URL放入队列,直到满足系统的一定停止条件。聚焦爬虫的工作流程较为复杂,需要根据一定的网页分析算法过滤与主题无关的链接,保留有用的链接并将其放入等待抓取的URL队列。然后,它将根据一定的搜索策略从队列中选择下一步要抓取的网页URL,并重复上述过程,直到达到系统的某一条件时停止。另外,所有被爬虫抓取的网页将会被系统存贮,进行一定的分析、过滤,并建立索引,以便之后的查询和检索;对于聚焦爬虫来说,这一过程所得到的分析结果还可能对以后的抓取过程给出反馈和指导。

世界上已经成型的爬虫软件多达上百种,本文对较为知名及常见的开源爬虫软件进行梳理,按开发语言进行汇总。虽然搜索引擎也有爬虫,但本次我汇总的只是爬虫软件,而非大型、复杂的搜索引擎,因为很多兄弟只是想爬取数据,而非运营一个搜索引擎。

Java爬虫

2.crawlzilla

crawlzilla 是一个帮你轻松建立搜索引擎的自由软件,有了它,你就不用依靠商业公司的搜索引擎,也不用再烦恼公司內部网站资料索引的问题。

由 nutch 专案为核心,并整合更多相关套件,并卡发设计安装与管理UI,让使用者更方便上手。

crawlzilla 除了爬取基本的 html 外,还能分析网页上的文件,如( doc、pdf、ppt、ooo、rss )等多种文件格式,让你的搜索引擎不只是网页搜索引擎,而是网站的完整资料索引库。

拥有中文分词能力,让你的搜索更精准。

crawlzilla的特色与目标,最主要就是提供使用者一个方便好用易安裝的搜索平台。

授权协议: Apache License 2

开发语言: Java JavaScript SHELL

操作系统: Linux

项目主页:

下载地址:

特点:安装简易,拥有中文分词功能

4.Heritrix

Heritrix 是一个由 java 开发的、开源的网络爬虫,用户可以使用它来从网上抓取想要的资源。其最出色之处在于它良好的可扩展性,方便用户实现自己的抓取逻辑。

Heritrix采用的是模块化的设计,各个模块由一个控制器类(CrawlController类)来协调,控制器是整体的核心。

代码托管:

授权协议: Apache

开发语言: Java

操作系统: 跨平台

特点:严格遵照robots文件的排除指示和META robots标签

6.ItSucks

ItSucks是一个java web spider(web机器人,爬虫)开源项目。支持通过下载模板和正则表达式来定义下载规则。提供一个swing GUI操作界面。

特点:提供swing GUI操作界面

8.JSpider

JSpider是一个用Java实现的WebSpider,JSpider的执行格式如下:

jspider [ConfigName]

URL一定要加上协议名称,如:,否则会报错。如果省掉ConfigName,则采用默认配置。

JSpider 的行为是由配置文件具体配置的,比如采用什么插件,结果存储方式等等都在conf[ConfigName]目录下设置。JSpider默认的配置种类 很少,用途也不大。但是JSpider非常容易扩展,可以利用它开发强大的网页抓取与数据分析工具。要做到这些,需要对JSpider的原理有深入的了 解,然后根据自己的需求开发插件,撰写配置文件。

授权协议: LGPL

开发语言: Java

操作系统: 跨平台

特点:功能强大,容易扩展

10.MetaSeeker

是一套完整的网页内容抓取、格式化、数据集成、存储管理和搜索解决方案。

网络爬虫有多种实现方法,如果按照部署在哪里分,可以分成:

1、服务器侧:一般是一个多线程程序,同时下载多个目标HTML,可以用PHP, Java, Python(当前很流行)等做,可以速度做得很快,一般综合搜索引擎的爬虫这样做。但是,如果对方讨厌爬虫,很可能封掉你的IP,服务器IP又不容易 改,另外耗用的带宽也是挺贵的。建议看一下Beautiful soap。