php抓取网页数据实例

php抓取网页数据实例(爱采汇手机版百度百度首页和移动端所有图片教程)

网站优化 • 优采云 发表了文章 • 0 个评论 • 89 次浏览 • 2021-10-11 22:01

php抓取网页数据实例,包括移动端php抓取以及php代码抓取大量图片网站,实例图:下载地址:,可以参考我之前的php抓取网页数据实例视频教程。

今天使用爱采汇手机版抓取百度首页和移动端所有图片。

chrome有一个扩展叫allphotos

lz说的是不是百度的图片爬虫?理论上是可以的,只是要求必须是自己开发的。

fiddler,可以抓包,还能看到mime头,然后就可以下载图片。

请问能详细说下网页爬虫包括哪些步骤吗?我一直想学python爬取图片下载。

这个还是比较好上手的,本人使用工具:webapp抓包工具fiddler+配置代理池(推荐proxyeehybrid)一整套下来就很简单了,本人现在正在学习如何爬取百度大图还没有完整写过.

fiddler+spiderpythonmongodbredis

fiddler抓包,然后看看自己想要哪些,可以进行json数据抓取,

抓取微博评论,

从importjson到python清理数据抓包,ssl一个包搞定。后面再用这个包分析一下图片,发现很多搜索结果,然后想看看这些结果的地址。到百度抓包,然后获取mime头, 查看全部

php抓取网页数据实例(爱采汇手机版百度百度首页和移动端所有图片教程)

php抓取网页数据实例,包括移动端php抓取以及php代码抓取大量图片网站,实例图:下载地址:,可以参考我之前的php抓取网页数据实例视频教程。

今天使用爱采汇手机版抓取百度首页和移动端所有图片。

chrome有一个扩展叫allphotos

lz说的是不是百度的图片爬虫?理论上是可以的,只是要求必须是自己开发的。

fiddler,可以抓包,还能看到mime头,然后就可以下载图片。

请问能详细说下网页爬虫包括哪些步骤吗?我一直想学python爬取图片下载。

这个还是比较好上手的,本人使用工具:webapp抓包工具fiddler+配置代理池(推荐proxyeehybrid)一整套下来就很简单了,本人现在正在学习如何爬取百度大图还没有完整写过.

fiddler+spiderpythonmongodbredis

fiddler抓包,然后看看自己想要哪些,可以进行json数据抓取,

抓取微博评论,

从importjson到python清理数据抓包,ssl一个包搞定。后面再用这个包分析一下图片,发现很多搜索结果,然后想看看这些结果的地址。到百度抓包,然后获取mime头,

php抓取网页数据实例(使用PHP的cURL库可以简单和有效地去抓网页。)

网站优化 • 优采云 发表了文章 • 0 个评论 • 60 次浏览 • 2021-10-11 14:24

使用 PHP 的 cURL 库来简单有效地抓取网页。你只需要运行一个脚本,然后分析你抓取的网页,然后你就可以通过编程的方式得到你想要的数据。无论您是想从链接中获取部分数据,还是获取 XML 文件并将其导入数据库,即使只是获取网页内容,cURL 都是一个强大的 PHP 库。本文主要介绍如何使用这个PHP库。

启用卷曲设置

首先我们要先判断我们的PHP是否启用了这个库,可以通过php_info()函数来获取这个信息。

﹤?php

phpinfo();

?﹥

如果在网页上可以看到如下输出,说明cURL库已经开启。

如果你看到它,那么你需要设置你的 PHP 并启用这个库。如果你是windows平台,很简单,你需要改变你的php.ini文件的设置,找到php_curl.dll,去掉前面的分号。如下:

//取消下在的注释

extension=php_curl.dll

如果你在 Linux 下,那么你需要重新编译你的 PHP。编辑时需要开启编译参数——在configure命令中添加“--with-curl”参数。

一个小例子

如果一切就绪,这里有一个小程序:

﹤?php

// 初始化一个 cURL 对象

$curl = curl_init();

// 设置你需要爬取的网址

curl_setopt($curl, CURLOPT_URL,'');

// 设置标题

curl_setopt($curl, CURLOPT_HEADER, 1);

// 设置cURL参数,询问结果是保存在字符串中还是输出到屏幕上。

curl_setopt($curl, CURLOPT_RETURNTRANSFER, 1);

// 运行 cURL 并请求一个网页

$data = curl_exec($curl);

// 关闭 URL 请求

curl_close($curl);

// 显示获取的数据

var_dump($data);

如何发布数据

上面是抓取网页的代码,下面是到某个网页的POST数据。假设我们有一个处理表单的URL,可以接受两个表单域,一个是电话号码,一个是短信内容。

﹤?php

$phoneNumber = '13912345678';

$message = 'This message was generated by curl and php';

$curlPost = 'pNUMBER=' . urlencode($phoneNumber) . '&MESSAGE=' . urlencode($message) . '&SUBMIT=Send';

$ch = curl_init();

curl_setopt($ch, CURLOPT_URL, 'http://www.example.com/sendSMS.php');

curl_setopt($ch, CURLOPT_HEADER, 1);

curl_setopt($ch, CURLOPT_RETURNTRANSFER, 1);

curl_setopt($ch, CURLOPT_POST, 1);

curl_setopt($ch, CURLOPT_POSTFIELDS, $curlPost);

$data = curl_exec();

curl_close($ch);

?﹥

从上面的程序可以看出,CURLOPT_POST是用来设置HTTP协议的POST方法而不是GET方法的,然后CURLOPT_POSTFIELDS是用来设置POST数据的。

关于代理服务器

以下是如何使用代理服务器的示例。请注意高亮的代码,代码很简单,我就不多说了。

﹤?php

$ch = curl_init();

curl_setopt($ch, CURLOPT_URL, 'http://www.example.com');

curl_setopt($ch, CURLOPT_HEADER, 1);

curl_setopt($ch, CURLOPT_RETURNTRANSFER, 1);

curl_setopt($ch, CURLOPT_HTTPPROXYTUNNEL, 1);

curl_setopt($ch, CURLOPT_PROXY, 'fakeproxy.com:1080');

curl_setopt($ch, CURLOPT_PROXYUSERPWD, 'user:password');

$data = curl_exec();

curl_close($ch);

?﹥

关于 SSL 和 Cookie 查看全部

php抓取网页数据实例(使用PHP的cURL库可以简单和有效地去抓网页。)

使用 PHP 的 cURL 库来简单有效地抓取网页。你只需要运行一个脚本,然后分析你抓取的网页,然后你就可以通过编程的方式得到你想要的数据。无论您是想从链接中获取部分数据,还是获取 XML 文件并将其导入数据库,即使只是获取网页内容,cURL 都是一个强大的 PHP 库。本文主要介绍如何使用这个PHP库。

启用卷曲设置

首先我们要先判断我们的PHP是否启用了这个库,可以通过php_info()函数来获取这个信息。

﹤?php

phpinfo();

?﹥

如果在网页上可以看到如下输出,说明cURL库已经开启。

如果你看到它,那么你需要设置你的 PHP 并启用这个库。如果你是windows平台,很简单,你需要改变你的php.ini文件的设置,找到php_curl.dll,去掉前面的分号。如下:

//取消下在的注释

extension=php_curl.dll

如果你在 Linux 下,那么你需要重新编译你的 PHP。编辑时需要开启编译参数——在configure命令中添加“--with-curl”参数。

一个小例子

如果一切就绪,这里有一个小程序:

﹤?php

// 初始化一个 cURL 对象

$curl = curl_init();

// 设置你需要爬取的网址

curl_setopt($curl, CURLOPT_URL,'');

// 设置标题

curl_setopt($curl, CURLOPT_HEADER, 1);

// 设置cURL参数,询问结果是保存在字符串中还是输出到屏幕上。

curl_setopt($curl, CURLOPT_RETURNTRANSFER, 1);

// 运行 cURL 并请求一个网页

$data = curl_exec($curl);

// 关闭 URL 请求

curl_close($curl);

// 显示获取的数据

var_dump($data);

如何发布数据

上面是抓取网页的代码,下面是到某个网页的POST数据。假设我们有一个处理表单的URL,可以接受两个表单域,一个是电话号码,一个是短信内容。

﹤?php

$phoneNumber = '13912345678';

$message = 'This message was generated by curl and php';

$curlPost = 'pNUMBER=' . urlencode($phoneNumber) . '&MESSAGE=' . urlencode($message) . '&SUBMIT=Send';

$ch = curl_init();

curl_setopt($ch, CURLOPT_URL, 'http://www.example.com/sendSMS.php');

curl_setopt($ch, CURLOPT_HEADER, 1);

curl_setopt($ch, CURLOPT_RETURNTRANSFER, 1);

curl_setopt($ch, CURLOPT_POST, 1);

curl_setopt($ch, CURLOPT_POSTFIELDS, $curlPost);

$data = curl_exec();

curl_close($ch);

?﹥

从上面的程序可以看出,CURLOPT_POST是用来设置HTTP协议的POST方法而不是GET方法的,然后CURLOPT_POSTFIELDS是用来设置POST数据的。

关于代理服务器

以下是如何使用代理服务器的示例。请注意高亮的代码,代码很简单,我就不多说了。

﹤?php

$ch = curl_init();

curl_setopt($ch, CURLOPT_URL, 'http://www.example.com');

curl_setopt($ch, CURLOPT_HEADER, 1);

curl_setopt($ch, CURLOPT_RETURNTRANSFER, 1);

curl_setopt($ch, CURLOPT_HTTPPROXYTUNNEL, 1);

curl_setopt($ch, CURLOPT_PROXY, 'fakeproxy.com:1080');

curl_setopt($ch, CURLOPT_PROXYUSERPWD, 'user:password');

$data = curl_exec();

curl_close($ch);

?﹥

关于 SSL 和 Cookie

php抓取网页数据实例( GET方法中的值和表单和值越过(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 102 次浏览 • 2021-10-11 14:20

GET方法中的值和表单和值越过(组图))

最近准备入手一个PHP爬虫,发现PHP的cURL是一个无法超越的知识点。本文讨论的是基础实战,需要提前了解命令行的使用,才能搭建PHP环境。

卷曲的概念

CURL,Client URL Library Functions,是一个开源文件传输工具,它使用 URL 语法在命令行模式下工作。广泛用于Unix和Linux发行版,在Win32、Win64下有移植版本。常用的cURL库libcurl支持http、https、ftp、gopher、telnet、dict、file和ldap协议。Libcurl 还支持HTTPS 认证、HTTP POST、HTTP PUT、FTP 上传(这也可以通过PHP 的FTP 扩展来完成)、基于HTTP 的表单上传、代理、cookie 和用户名+密码认证。

[图片上传失败...(image-cc9fed-83)]](//upload-images.jianshu.io/upload_images/2558748-f4dcbe5d6e4e7097.png?imageMogr2/auto-orient/strip %7CimageView2/2/w/1240)

简而言之,cURL 是一个客户端启动的管理程序,支持大多数 Internet 协议族,可以下载或上传网络文件。

命令行上的cURL可以爬取什么网页源码?

打开命令行,输入以下命令,向百度服务器发送获取首页源码的请求。>命令将源代码输出保存到当前目录下的baidu.html。

curl https://www.baidu.com > baidu.html

获取表单 · GET 或 POST 方法

网页中的标签通常用于生成表单。当我们点击表单中的提交按钮时,浏览器会对表单中填写的所有参数进行分析和打包,最后使用指定的HTTP方式发送到目标网络地址。

下图代码将用户在输入框中填写的参数信息添加到URL地址中,并发送GET方法到目标服务器下的jugment.php。在 GET 方法中,该值对应于表单中的每个字段。

GET方法中的参数会出现在URL地址中,所以我们也在命令行cURL下模拟这个。

curl www.example.com/judge.php?year=1997&press=ok

URL 语法表示一般的 URL 地址格式如下。不难看出,上面示例代码中的year字段及其值是

实例。

://:@:/:?#

与 GET 方法不同,HTTP 中的 POST 请求向服务器发送数据。因为经常有账号、密码等隐私信息,这些数据通常会被添加到URL地址中不可见的HTML Header中,并将数据发送到目标服务器。

在命令行中,curl 将 POST 方法作为 -d 参数处理。

curl -d "year=1997&press=OK" www.example.com/judge.php

上传文件 · POST 或 PUT 方法

1995 年底,RFC 1867 定义了一种新的上传文件的 POST 方法。主要用于上传本地文件到服务器。这时候页面是这样写的:

对应的 cURL 命令使用 -F 作为命令参数,如下所示。

curl -F upload=@localfilename -F press=OK URL

HTTP协议文件上传的标准方法是使用PUT,在这种情况下cURL命令使用-T参数:

curl -T uploadfile www.uploadhttp. com/receive.php

冒充指定客户

有些网络资源首先需要判断用户使用的是什么浏览器,符合标准后才能下载或浏览。此时,curl 可以“伪装”为任何其他浏览器:

curl -A "Mozilla/4.0 (compatible; MSIE 5.01; Windows NT 5.0)" URL

该命令表示cURL伪装成IE5.0,用户平台为Windows 2000。

curl -A "Mozilla/4.73 [en] (X11; U; Linux 2.2.15 i686)" URL

这时候curl变成了Netscape,运行在PIII平台的Linux上。

和更多

cURL的概念部分提到过,cURL的功能除了请求网页、上传文件、伪装外,还包括使用cookies访问目标服务器(参数-b)、访问加密的HTTP页面(HTTPS)、访问使用需要证书身份验证的本地证书。HTTP地址(参数-E)、授权、可续传、代理设置和网络限速等,网络上的所有资源都可以通过cURL访问和下载。

在 PHP 中使用 cURL

由 Daniel Stenberg 创建的 libcurl 库由 PHP 支持,允许我们使用各种类型的协议与各种服务器连接和通信。

为了使用 cURL 功能,您需要安装 cURL 包。PHP 要求我们使用 cURL 7.0.2-beta 或更高版本。如果 curl 的版本低于 7.0.2-beta,PHP 将无法运行。

要使用 PHP 的 CURL 支持,我们必须使用 --with-curl[=DIR] 参数(DIR 是收录库和头文件的目录)重新编译 PHP。

在前面提到的命令行下curl的实现中,我们不难理解PHP中的curl函数:首先使用curl_init()函数来初始化curl会话,然后就可以设置所有与curl相关的选项curl 进程,并通过 curl_exec() 函数执行它。最后,我们可以使用 curl_close() 函数结束当前会话并节省资源。下面是MOOC上PHP中curl过程的说明。

[图片上传失败...(image-1c28eb-84)]](//upload-images.jianshu.io/upload_images/2558748-d0b8cacdffe9766e.png?imageMogr2/auto-orient/strip%7CimageView2/2 /w/1240)

安装卷曲

Mac 自带的 PHP 环境对 cURL 提供了很好的支持。如果它不是 Macintosh,也许这些可以帮助:

一般Linux下CURL安装

获取安装包,直接从网上下载或者其他方式,这里直接wget

# wget http://curl.haxx.se/download/curl-7.17.1.tar.gz

解压到当前目录,输入

# tar -zxf curl-7.17.1.tar.gz & cd curl-7.17.1

配置,指定安装目录,这里是“/usr/local/curl”

# ./configure –prefix=/usr/local/curl

编译安装

# make & make install

安装完成后,在环境变量中添加 curl 命令。

# export PATH=$PATH:/usr/local/curl/bin

Ubuntu小curl安装

Ubuntu 自带的 apt-get 包管理器可以帮助我们解决所有的依赖。

sudo apt-get install curl libcurl3 libcurl3-dev php5-curl

然后重启服务器,这里是apache服务器。

sudo /etc/init.d/apache2 restart

Windows下的扩展

Windows下安装PHP后,将PHP文件夹下的三个文件php_curl.dll、libeay32.dll、ssleay32.dll复制到system32,然后复制php.ini(c:WINDOWS去掉分号后在 ;extension=php_curl.dll 目录下),重启服务器。

开始实战

这里从简单到复杂的小Demo,一步一步来。

使用 curl 制作一个简单的网络爬虫

将以下PHP代码保存为example1.php并在命令行执行。

php -f example1.php > baidu1.html

open baidu1.html

使用curl抓取网页信息并替换部分内容

将以下PHP代码保存为example2.php并在命令行执行。

php -f example2.php > baidu2.html

open baidu2.html

使用 curl 获取天气信息

将以下PHP代码保存为example2.php并在命令行执行。

php -f example2.php > weather.html

open weather.html

本文介绍了cURL的基础知识以及cURL在PHP中的基础实战。更多高级用法,敬请期待。 查看全部

php抓取网页数据实例(

GET方法中的值和表单和值越过(组图))

最近准备入手一个PHP爬虫,发现PHP的cURL是一个无法超越的知识点。本文讨论的是基础实战,需要提前了解命令行的使用,才能搭建PHP环境。

卷曲的概念

CURL,Client URL Library Functions,是一个开源文件传输工具,它使用 URL 语法在命令行模式下工作。广泛用于Unix和Linux发行版,在Win32、Win64下有移植版本。常用的cURL库libcurl支持http、https、ftp、gopher、telnet、dict、file和ldap协议。Libcurl 还支持HTTPS 认证、HTTP POST、HTTP PUT、FTP 上传(这也可以通过PHP 的FTP 扩展来完成)、基于HTTP 的表单上传、代理、cookie 和用户名+密码认证。

[图片上传失败...(image-cc9fed-83)]](//upload-images.jianshu.io/upload_images/2558748-f4dcbe5d6e4e7097.png?imageMogr2/auto-orient/strip %7CimageView2/2/w/1240)

简而言之,cURL 是一个客户端启动的管理程序,支持大多数 Internet 协议族,可以下载或上传网络文件。

命令行上的cURL可以爬取什么网页源码?

打开命令行,输入以下命令,向百度服务器发送获取首页源码的请求。>命令将源代码输出保存到当前目录下的baidu.html。

curl https://www.baidu.com > baidu.html

获取表单 · GET 或 POST 方法

网页中的标签通常用于生成表单。当我们点击表单中的提交按钮时,浏览器会对表单中填写的所有参数进行分析和打包,最后使用指定的HTTP方式发送到目标网络地址。

下图代码将用户在输入框中填写的参数信息添加到URL地址中,并发送GET方法到目标服务器下的jugment.php。在 GET 方法中,该值对应于表单中的每个字段。

GET方法中的参数会出现在URL地址中,所以我们也在命令行cURL下模拟这个。

curl www.example.com/judge.php?year=1997&press=ok

URL 语法表示一般的 URL 地址格式如下。不难看出,上面示例代码中的year字段及其值是

实例。

://:@:/:?#

与 GET 方法不同,HTTP 中的 POST 请求向服务器发送数据。因为经常有账号、密码等隐私信息,这些数据通常会被添加到URL地址中不可见的HTML Header中,并将数据发送到目标服务器。

在命令行中,curl 将 POST 方法作为 -d 参数处理。

curl -d "year=1997&press=OK" www.example.com/judge.php

上传文件 · POST 或 PUT 方法

1995 年底,RFC 1867 定义了一种新的上传文件的 POST 方法。主要用于上传本地文件到服务器。这时候页面是这样写的:

对应的 cURL 命令使用 -F 作为命令参数,如下所示。

curl -F upload=@localfilename -F press=OK URL

HTTP协议文件上传的标准方法是使用PUT,在这种情况下cURL命令使用-T参数:

curl -T uploadfile www.uploadhttp. com/receive.php

冒充指定客户

有些网络资源首先需要判断用户使用的是什么浏览器,符合标准后才能下载或浏览。此时,curl 可以“伪装”为任何其他浏览器:

curl -A "Mozilla/4.0 (compatible; MSIE 5.01; Windows NT 5.0)" URL

该命令表示cURL伪装成IE5.0,用户平台为Windows 2000。

curl -A "Mozilla/4.73 [en] (X11; U; Linux 2.2.15 i686)" URL

这时候curl变成了Netscape,运行在PIII平台的Linux上。

和更多

cURL的概念部分提到过,cURL的功能除了请求网页、上传文件、伪装外,还包括使用cookies访问目标服务器(参数-b)、访问加密的HTTP页面(HTTPS)、访问使用需要证书身份验证的本地证书。HTTP地址(参数-E)、授权、可续传、代理设置和网络限速等,网络上的所有资源都可以通过cURL访问和下载。

在 PHP 中使用 cURL

由 Daniel Stenberg 创建的 libcurl 库由 PHP 支持,允许我们使用各种类型的协议与各种服务器连接和通信。

为了使用 cURL 功能,您需要安装 cURL 包。PHP 要求我们使用 cURL 7.0.2-beta 或更高版本。如果 curl 的版本低于 7.0.2-beta,PHP 将无法运行。

要使用 PHP 的 CURL 支持,我们必须使用 --with-curl[=DIR] 参数(DIR 是收录库和头文件的目录)重新编译 PHP。

在前面提到的命令行下curl的实现中,我们不难理解PHP中的curl函数:首先使用curl_init()函数来初始化curl会话,然后就可以设置所有与curl相关的选项curl 进程,并通过 curl_exec() 函数执行它。最后,我们可以使用 curl_close() 函数结束当前会话并节省资源。下面是MOOC上PHP中curl过程的说明。

[图片上传失败...(image-1c28eb-84)]](//upload-images.jianshu.io/upload_images/2558748-d0b8cacdffe9766e.png?imageMogr2/auto-orient/strip%7CimageView2/2 /w/1240)

安装卷曲

Mac 自带的 PHP 环境对 cURL 提供了很好的支持。如果它不是 Macintosh,也许这些可以帮助:

一般Linux下CURL安装

获取安装包,直接从网上下载或者其他方式,这里直接wget

# wget http://curl.haxx.se/download/curl-7.17.1.tar.gz

解压到当前目录,输入

# tar -zxf curl-7.17.1.tar.gz & cd curl-7.17.1

配置,指定安装目录,这里是“/usr/local/curl”

# ./configure –prefix=/usr/local/curl

编译安装

# make & make install

安装完成后,在环境变量中添加 curl 命令。

# export PATH=$PATH:/usr/local/curl/bin

Ubuntu小curl安装

Ubuntu 自带的 apt-get 包管理器可以帮助我们解决所有的依赖。

sudo apt-get install curl libcurl3 libcurl3-dev php5-curl

然后重启服务器,这里是apache服务器。

sudo /etc/init.d/apache2 restart

Windows下的扩展

Windows下安装PHP后,将PHP文件夹下的三个文件php_curl.dll、libeay32.dll、ssleay32.dll复制到system32,然后复制php.ini(c:WINDOWS去掉分号后在 ;extension=php_curl.dll 目录下),重启服务器。

开始实战

这里从简单到复杂的小Demo,一步一步来。

使用 curl 制作一个简单的网络爬虫

将以下PHP代码保存为example1.php并在命令行执行。

php -f example1.php > baidu1.html

open baidu1.html

使用curl抓取网页信息并替换部分内容

将以下PHP代码保存为example2.php并在命令行执行。

php -f example2.php > baidu2.html

open baidu2.html

使用 curl 获取天气信息

将以下PHP代码保存为example2.php并在命令行执行。

php -f example2.php > weather.html

open weather.html

本文介绍了cURL的基础知识以及cURL在PHP中的基础实战。更多高级用法,敬请期待。

php抓取网页数据实例(最新更新()2019年7月24日20点2319(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 112 次浏览 • 2021-10-03 15:11

最新更新

CentOS上安装redis,启动redis;将数据存储在redis中。2019年7月24日20时2019-07-25

用virtualbox安装centos并配置网络。2019年7月22日20时2019-07-22

使用正则表达式抓取京东商城列表。(我用三个表达式抓取了产品库ID、产品名称和产品图片;用PHP嵌入HTML并制作了一个点击查询数据库数据的页面)2019年6月28日20点2019-07-06

使用聚合数据提供的接口查询手机号码归属地。2019 年 6 月 26 日 2019-06-26

我自己对爬虫的理解2019-06-24

写一个数据库操作类,需要使用命名空间、类继承、后期绑定访问,实现对数据表的简单访问(使用接口定义常量,类完成接口连接数据库方法,课外执行数据库操作指令并打印结果)2019年6月19日20时2019-06-22

根据类案例,写一个接口完成基本的数据表操作:CURD(使用接口和类中的方法对数据库进行增删改查) 2019-06-19 20点2019-06- 21

使用静态方法重载技术实现一个数据库访问类,并演示链接调用的实现过程(通过静态魔术方法跳转实现对象方法__callStatic的跨类调用) 2019-06-17 20:00 2019-06-19

博文分类

PHP36篇

HTML2 文章

CSS2

JavaScript 2

热门文章

CentOS上安装redis,启动redis;将数据存储在redis中。2019 年 7 月 24 日 20:2319

使用iframe和ajax实现网站后台架构和功能;使用bootstrap美化网站后台管理系统(掌握iframe和ajax实现网站后台的使用;使用bootstrap美化后台页面) 2019年01月30日20:1909

编写一个引导模板;编写一个适应所有阈值的小网格布局案例;写一个模仿课堂案例的布局页面(web开发使用bootstrap框架,使用bootstrap查看组件说明并使用) 2019-05-24 20:00 1446

$.get(), $.post(), $.ajax() 小练习(使用$.get()从服务器获取图片文本输出到页面进行DOM操作;使用$.post() , $.ajax( )从服务器返回值验证预设邮箱密码登录验证) 2019-05-22 20:1327

用面向对象的知识写一个学生信息类(使用类构造、属性访问、输出模板设置、类继承) 2019-06-13 20:775

创建二维数组并遍历;使用数组遍历生成表(使用二维数据生成表,使用foreach()遍历数组数据) 2019-06-04 20:740

使用聚合数据提供的接口查询手机号码归属地。2019 年 6 月 26 日 668

写出PDO操作数据库的基本步骤;制作学生数据库和学生信息表(写完PDO步骤后,添加SQL语句模板,使用预处理方式对数据库进行增删改查)2019年6月5日20点663 查看全部

php抓取网页数据实例(最新更新()2019年7月24日20点2319(组图))

最新更新

CentOS上安装redis,启动redis;将数据存储在redis中。2019年7月24日20时2019-07-25

用virtualbox安装centos并配置网络。2019年7月22日20时2019-07-22

使用正则表达式抓取京东商城列表。(我用三个表达式抓取了产品库ID、产品名称和产品图片;用PHP嵌入HTML并制作了一个点击查询数据库数据的页面)2019年6月28日20点2019-07-06

使用聚合数据提供的接口查询手机号码归属地。2019 年 6 月 26 日 2019-06-26

我自己对爬虫的理解2019-06-24

写一个数据库操作类,需要使用命名空间、类继承、后期绑定访问,实现对数据表的简单访问(使用接口定义常量,类完成接口连接数据库方法,课外执行数据库操作指令并打印结果)2019年6月19日20时2019-06-22

根据类案例,写一个接口完成基本的数据表操作:CURD(使用接口和类中的方法对数据库进行增删改查) 2019-06-19 20点2019-06- 21

使用静态方法重载技术实现一个数据库访问类,并演示链接调用的实现过程(通过静态魔术方法跳转实现对象方法__callStatic的跨类调用) 2019-06-17 20:00 2019-06-19

博文分类

PHP36篇

HTML2 文章

CSS2

JavaScript 2

热门文章

CentOS上安装redis,启动redis;将数据存储在redis中。2019 年 7 月 24 日 20:2319

使用iframe和ajax实现网站后台架构和功能;使用bootstrap美化网站后台管理系统(掌握iframe和ajax实现网站后台的使用;使用bootstrap美化后台页面) 2019年01月30日20:1909

编写一个引导模板;编写一个适应所有阈值的小网格布局案例;写一个模仿课堂案例的布局页面(web开发使用bootstrap框架,使用bootstrap查看组件说明并使用) 2019-05-24 20:00 1446

$.get(), $.post(), $.ajax() 小练习(使用$.get()从服务器获取图片文本输出到页面进行DOM操作;使用$.post() , $.ajax( )从服务器返回值验证预设邮箱密码登录验证) 2019-05-22 20:1327

用面向对象的知识写一个学生信息类(使用类构造、属性访问、输出模板设置、类继承) 2019-06-13 20:775

创建二维数组并遍历;使用数组遍历生成表(使用二维数据生成表,使用foreach()遍历数组数据) 2019-06-04 20:740

使用聚合数据提供的接口查询手机号码归属地。2019 年 6 月 26 日 668

写出PDO操作数据库的基本步骤;制作学生数据库和学生信息表(写完PDO步骤后,添加SQL语句模板,使用预处理方式对数据库进行增删改查)2019年6月5日20点663

php抓取网页数据实例(PHP缓存机制静态化:把动态页面解析后保存为文件)

网站优化 • 优采云 发表了文章 • 0 个评论 • 119 次浏览 • 2021-10-01 11:17

前台静态:解析后将动态页面保存为静态页面

文件缓存:将查询结果保存为文件,XML

内存缓存:memcache

php缓存:XCache、eaccelerator等。

Memcache 是一个高性能的分布式内存对象缓存系统。通过在内存中维护一个统一的巨大哈希表,它可以用来存储各种格式的数据,包括图像、视频、文件,以及数据库检索的结果等。简单的说就是将数据调用到内存中再从内存中读取,从而大大提高了读取速度。Memcache 是 danga 的一个项目。它最初由 LiveJournal 提供服务。它最初是为了加快LiveJournal的访问速度而开发的,后来被许多大型网站采用。Memcached 作为守护进程运行在一台或多台服务器上,随时接收客户端的连接和操作。

XCache 是一个开源操作码缓存/优化器,这意味着它可以提高 PHP 在您的服务器上的性能。它通过将已编译的 PHP 数据缓冲到共享内存中来避免重复编译过程,并且可以直接使用缓冲区已经编译的代码从而提高速度。通常它可以将您的页面生成率提高 2 到 5 倍并减少服务器负载。

****************************************************** ****************************************************** ******************************************************

1、通用缓存技术:

数据缓存:这里所说的数据缓存是指数据库查询的PHP缓存机制。每次访问该页面时,首先会检查相应的缓存数据是否存在。如果不存在,则连接数据库,获取数据,对查询结果进行排序。转换后保存到文件中,以后直接从缓存表或文件中得到同样的查询结果。

使用最广泛的例子是Discuz的搜索功能,将结果ID缓存在一张表中,下次搜索同一个关键词时先搜索缓存表。

作为一种常见的方法,当多个表关联时,将附表中的内容生成一个数组保存在主表的一个字段中,需要时再分解该数组。这样做的好处是只读取一张表,坏处是两张数据。同步的步骤会多很多,数据库永远是瓶颈。用硬盘改变速度是这个的关键点。

2、 页面缓存:

每次访问一个页面时,首先会检查对应的缓存页面文件是否存在。如果不存在,会同时连接数据库,获取数据,显示页面,生成缓存页面文件,以便下次访问时页面文件发挥作用。. (模板引擎和网上一些常见的PHP缓存机制类通常都有这个功能)

3、 时间触发缓存:

检查文件是否存在,时间戳是否小于设置的过期时间。如果文件修改的时间戳大于当前时间戳减去过期时间戳,则使用缓存,否则更新缓存。

4、 内容触发缓存:

当数据被插入或更新时,PHP 缓存机制会被强制更新。

5、 静态缓存:

这里所说的静态缓存是指静态的,直接生成HTML或XML等文本文件,有更新的时候重新生成一次,适用于变化不大的页面,就不多说了。

上面的内容是代码级的解决方案,我直接CP其他框架,懒得改了,内容差不多,做起来很简单,会用好几种方式,不过下面的内容是服务器-侧缓存方案,不是代码级别的,只有多方合作才能实现

6、 内存缓存:

Memcached 是一种高性能、分布式内存对象 PHP 缓存机制系统,用于在动态应用中减少数据库负载和提高访问速度。

7、 php 缓冲区:

还有eaccelerator、apc、phpa、xcache,更不用说这个了

8、 MYSQL 缓存:

这个也是非代码级别的,经典数据库就是这样使用的,看下面的运行时间,比如0.09xxx

9、 基于反向代理的Web缓存:

如Nginx、SQUID、mod_proxy(apache2及以上分为mod_proxy和mod_cache)

10、 DNS 轮询:

BIND 是一个开源的 DNS 服务器软件。这是一件大事。自行搜索。每个人都知道有这个东西。

我知道有些大网站比如chinacache就是这样做的。简单来说,就是多台服务器。同一个页面或文件缓存在不同的服务器上,根据南北自动解析到相关服务器。

PHP 网页缓存示例

有了这三个php函数,就可以实现强大的功能。如果数据库查询量很大,可以使用缓存来解决这个问题。

首先,设置过期时间。如果要求缓存文件在2小时内过期,可以设置cache_time为3600*2;使用filectime()获取缓存文件的创建时间(或filemtime()获取修改时间),如果当前时间后文件的创建时间超过了限定的过期时间,可以使用以上三个函数先从数据库中取数据,然后开始缓存ob_start(),然后在缓存中写入要生成的页面的html代码。缓存结束后通过ob_get_contents()获取缓存的内容,然后通过fwrite将缓存的内容写入静态页面html。

如果没有过期,直接读取缓存中的静态页面,避免大量的数据库访问。

<p> 查看全部

php抓取网页数据实例(PHP缓存机制静态化:把动态页面解析后保存为文件)

前台静态:解析后将动态页面保存为静态页面

文件缓存:将查询结果保存为文件,XML

内存缓存:memcache

php缓存:XCache、eaccelerator等。

Memcache 是一个高性能的分布式内存对象缓存系统。通过在内存中维护一个统一的巨大哈希表,它可以用来存储各种格式的数据,包括图像、视频、文件,以及数据库检索的结果等。简单的说就是将数据调用到内存中再从内存中读取,从而大大提高了读取速度。Memcache 是 danga 的一个项目。它最初由 LiveJournal 提供服务。它最初是为了加快LiveJournal的访问速度而开发的,后来被许多大型网站采用。Memcached 作为守护进程运行在一台或多台服务器上,随时接收客户端的连接和操作。

XCache 是一个开源操作码缓存/优化器,这意味着它可以提高 PHP 在您的服务器上的性能。它通过将已编译的 PHP 数据缓冲到共享内存中来避免重复编译过程,并且可以直接使用缓冲区已经编译的代码从而提高速度。通常它可以将您的页面生成率提高 2 到 5 倍并减少服务器负载。

****************************************************** ****************************************************** ******************************************************

1、通用缓存技术:

数据缓存:这里所说的数据缓存是指数据库查询的PHP缓存机制。每次访问该页面时,首先会检查相应的缓存数据是否存在。如果不存在,则连接数据库,获取数据,对查询结果进行排序。转换后保存到文件中,以后直接从缓存表或文件中得到同样的查询结果。

使用最广泛的例子是Discuz的搜索功能,将结果ID缓存在一张表中,下次搜索同一个关键词时先搜索缓存表。

作为一种常见的方法,当多个表关联时,将附表中的内容生成一个数组保存在主表的一个字段中,需要时再分解该数组。这样做的好处是只读取一张表,坏处是两张数据。同步的步骤会多很多,数据库永远是瓶颈。用硬盘改变速度是这个的关键点。

2、 页面缓存:

每次访问一个页面时,首先会检查对应的缓存页面文件是否存在。如果不存在,会同时连接数据库,获取数据,显示页面,生成缓存页面文件,以便下次访问时页面文件发挥作用。. (模板引擎和网上一些常见的PHP缓存机制类通常都有这个功能)

3、 时间触发缓存:

检查文件是否存在,时间戳是否小于设置的过期时间。如果文件修改的时间戳大于当前时间戳减去过期时间戳,则使用缓存,否则更新缓存。

4、 内容触发缓存:

当数据被插入或更新时,PHP 缓存机制会被强制更新。

5、 静态缓存:

这里所说的静态缓存是指静态的,直接生成HTML或XML等文本文件,有更新的时候重新生成一次,适用于变化不大的页面,就不多说了。

上面的内容是代码级的解决方案,我直接CP其他框架,懒得改了,内容差不多,做起来很简单,会用好几种方式,不过下面的内容是服务器-侧缓存方案,不是代码级别的,只有多方合作才能实现

6、 内存缓存:

Memcached 是一种高性能、分布式内存对象 PHP 缓存机制系统,用于在动态应用中减少数据库负载和提高访问速度。

7、 php 缓冲区:

还有eaccelerator、apc、phpa、xcache,更不用说这个了

8、 MYSQL 缓存:

这个也是非代码级别的,经典数据库就是这样使用的,看下面的运行时间,比如0.09xxx

9、 基于反向代理的Web缓存:

如Nginx、SQUID、mod_proxy(apache2及以上分为mod_proxy和mod_cache)

10、 DNS 轮询:

BIND 是一个开源的 DNS 服务器软件。这是一件大事。自行搜索。每个人都知道有这个东西。

我知道有些大网站比如chinacache就是这样做的。简单来说,就是多台服务器。同一个页面或文件缓存在不同的服务器上,根据南北自动解析到相关服务器。

PHP 网页缓存示例

有了这三个php函数,就可以实现强大的功能。如果数据库查询量很大,可以使用缓存来解决这个问题。

首先,设置过期时间。如果要求缓存文件在2小时内过期,可以设置cache_time为3600*2;使用filectime()获取缓存文件的创建时间(或filemtime()获取修改时间),如果当前时间后文件的创建时间超过了限定的过期时间,可以使用以上三个函数先从数据库中取数据,然后开始缓存ob_start(),然后在缓存中写入要生成的页面的html代码。缓存结束后通过ob_get_contents()获取缓存的内容,然后通过fwrite将缓存的内容写入静态页面html。

如果没有过期,直接读取缓存中的静态页面,避免大量的数据库访问。

<p>

php抓取网页数据实例(以人教版地理七年级为例子,到电子课本网下载一本电子书 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 86 次浏览 • 2021-10-01 06:14

)

我需要写一个这样的例子并从电子教科书网站下载一本电子书。

电子教科书网的电子书把书的每一页都当成一张图,然后一本书有很多图,我需要批量下载图片。

这是代码部分:

public function download() {

$http = new \Org\Net\Http();

$url_pref = "http://www.dzkbw.com/books/rjb/dili/xc7s/";

$localUrl = "Public/bookcover/";

$reg="|showImg\('(.+)'\);|";

$i=1;

do {

$filename = substr("000".$i,-3).".htm";

$ch = curl_init();

curl_setopt($ch, CURLOPT_URL, $url_pref.$filename);

curl_setopt($ch, CURLOPT_RETURNTRANSFER, 1);

curl_setopt($ch, CURLOPT_CONNECTTIMEOUT, 10);

curl_setopt($ch, CURLOPT_FOLLOWLOCATION, 1);

$html = curl_exec($ch);

curl_close($ch);

$result = preg_match_all($reg,$html,$out, PREG_PATTERN_ORDER);

if($result==1) {

$picUrl = $out[1][0];

$picFilename = substr("000".$i,-3).".jpg";

$http->curlDownload($picUrl, $localUrl.$picFilename);

}

$i = $i+1;

} while ($result==1);

echo "下载完成";

}

这里我以人民教育出版社出版的七年级地理第一册为例。

网页从001.htm开始,然后不断增加

每个网页都有一张图片,与课本的内容相对应。课本内容以图片的形式展示。

我的代码是做一个循环,从第一页开始,直到在网页中找不到图片。

抓取网页内容后,抓取网页中的图片到本地服务器

爬取后的实际效果:

查看全部

php抓取网页数据实例(以人教版地理七年级为例子,到电子课本网下载一本电子书

)

我需要写一个这样的例子并从电子教科书网站下载一本电子书。

电子教科书网的电子书把书的每一页都当成一张图,然后一本书有很多图,我需要批量下载图片。

这是代码部分:

public function download() {

$http = new \Org\Net\Http();

$url_pref = "http://www.dzkbw.com/books/rjb/dili/xc7s/";

$localUrl = "Public/bookcover/";

$reg="|showImg\('(.+)'\);|";

$i=1;

do {

$filename = substr("000".$i,-3).".htm";

$ch = curl_init();

curl_setopt($ch, CURLOPT_URL, $url_pref.$filename);

curl_setopt($ch, CURLOPT_RETURNTRANSFER, 1);

curl_setopt($ch, CURLOPT_CONNECTTIMEOUT, 10);

curl_setopt($ch, CURLOPT_FOLLOWLOCATION, 1);

$html = curl_exec($ch);

curl_close($ch);

$result = preg_match_all($reg,$html,$out, PREG_PATTERN_ORDER);

if($result==1) {

$picUrl = $out[1][0];

$picFilename = substr("000".$i,-3).".jpg";

$http->curlDownload($picUrl, $localUrl.$picFilename);

}

$i = $i+1;

} while ($result==1);

echo "下载完成";

}

这里我以人民教育出版社出版的七年级地理第一册为例。

网页从001.htm开始,然后不断增加

每个网页都有一张图片,与课本的内容相对应。课本内容以图片的形式展示。

我的代码是做一个循环,从第一页开始,直到在网页中找不到图片。

抓取网页内容后,抓取网页中的图片到本地服务器

爬取后的实际效果:

php抓取网页数据实例(php抓取网页数据实例,经典案例,常用工具,分析思路)

网站优化 • 优采云 发表了文章 • 0 个评论 • 66 次浏览 • 2021-09-26 03:03

php抓取网页数据实例,经典案例,常用工具,分析思路,演示代码github地址,欢迎提star,,

说两个for循环。第一个,检查网页内容,是否一致。如果不一致,直接content_type='text/plain',然后去掉不允许的字符即可。如果一致,那就继续处理。第二个,检查网页,去掉header部分,然后生成正则表达式,匹配内容。把所有的都匹配一遍,得到需要的数据。

我将pythonweb的操作方法都写出来,

1、采集并保存for循环

2、完成数据的预处理

3、去除掉无用的数据源文件

4、读取并保存数据库

web抓取真不是那么好写的,一两句话就把网页内容都处理掉你确定用户的数据抓得下来么?先对网页原始内容进行预处理吧,只需要做提取要用到的关键字和数据内容,注意优先选取网页中该行最大的那一句话。

有的函数

非常感谢

无注释无重复代码,从网页的第一句开始抓取数据,

二分法,对多个项目分级抓取,可以少很多工作量。

别走二元法哈!!!二元法,你按照是否断言的顺序查询比较快,而且思路清晰,而这种方法则需要对网页有比较深入的理解(前提是你先需要记住url,不然只管抓了也很难用),对于新网站的话, 查看全部

php抓取网页数据实例(php抓取网页数据实例,经典案例,常用工具,分析思路)

php抓取网页数据实例,经典案例,常用工具,分析思路,演示代码github地址,欢迎提star,,

说两个for循环。第一个,检查网页内容,是否一致。如果不一致,直接content_type='text/plain',然后去掉不允许的字符即可。如果一致,那就继续处理。第二个,检查网页,去掉header部分,然后生成正则表达式,匹配内容。把所有的都匹配一遍,得到需要的数据。

我将pythonweb的操作方法都写出来,

1、采集并保存for循环

2、完成数据的预处理

3、去除掉无用的数据源文件

4、读取并保存数据库

web抓取真不是那么好写的,一两句话就把网页内容都处理掉你确定用户的数据抓得下来么?先对网页原始内容进行预处理吧,只需要做提取要用到的关键字和数据内容,注意优先选取网页中该行最大的那一句话。

有的函数

非常感谢

无注释无重复代码,从网页的第一句开始抓取数据,

二分法,对多个项目分级抓取,可以少很多工作量。

别走二元法哈!!!二元法,你按照是否断言的顺序查询比较快,而且思路清晰,而这种方法则需要对网页有比较深入的理解(前提是你先需要记住url,不然只管抓了也很难用),对于新网站的话,

php抓取网页数据实例( PHP缓存机制静态化:把动态页面解析后保存为文件)

网站优化 • 优采云 发表了文章 • 0 个评论 • 159 次浏览 • 2021-09-26 00:14

PHP缓存机制静态化:把动态页面解析后保存为文件)

前台静态:解析后将动态页面保存为静态页面

文件缓存:将查询结果保存为文件,XML

内存缓存:memcache

php缓存:XCache、eaccelerator等。

Memcache 是一个高性能的分布式内存对象缓存系统。通过在内存中维护一个统一的巨大哈希表,它可以用来存储各种格式的数据,包括图像、视频、文件,以及数据库检索的结果等。简单的说就是将数据调用到内存中再从内存中读取,从而大大提高了读取速度。Memcache 是 danga 的一个项目。它最初由 LiveJournal 提供服务。它最初是为了加快LiveJournal的访问速度而开发的,后来被很多大型网站采用。Memcached 作为守护进程运行在一台或多台服务器上,随时接收客户端的连接和操作。

XCache 是一个开源操作码缓存/优化器,这意味着它可以提高 PHP 在您的服务器上的性能。它通过将已编译的 PHP 数据缓冲到共享内存中来避免重复编译过程,并且可以直接使用缓冲区已经编译的代码从而提高速度。通常它可以将您的页面生成率提高 2 到 5 倍并减少服务器负载。

****************************************************** ****************************************************** ******************************************************

1、通用缓存技术:

数据缓存:这里所说的数据缓存是指数据库查询的PHP缓存机制。每次访问该页面时,首先会检查相应的缓存数据是否存在。如果不存在,则连接数据库,获取数据,对查询结果进行排序。转换后保存到文件中,以后直接从缓存表或文件中得到同样的查询结果。

使用最广泛的例子是Discuz的搜索功能,将结果ID缓存在一张表中,下次搜索同一个关键词时先搜索缓存表。

作为一种常见的方法,当多个表关联时,将附表中的内容生成一个数组保存在主表的一个字段中,需要时再分解该数组。这样做的好处是只读取一张表,坏处是两张数据。同步的步骤会多很多,数据库永远是瓶颈。用硬盘改变速度是这个的关键点。

2、 页面缓存:

每次访问一个页面时,首先会检查对应的缓存页面文件是否存在。如果不存在,会同时连接数据库,获取数据,显示页面,生成缓存页面文件,以便下次访问时页面文件发挥作用。. (模板引擎和网上一些常见的PHP缓存机制类通常都有这个功能)

3、 时间触发缓存:

检查文件是否存在,时间戳是否小于设置的过期时间。如果文件修改的时间戳大于当前时间戳减去过期时间戳,则使用缓存,否则更新缓存。

4、 内容触发缓存:

当数据被插入或更新时,PHP 缓存机制会被强制更新。

5、 静态缓存:

这里所说的静态缓存是指静态的,直接生成HTML或者XML等文本文件,有更新的时候重新生成一次,适用于变化不大的页面,就不多说了。

上面的内容是代码级的解决方案,我直接CP其他框架,懒得改了,内容差不多,做起来很简单,会用好几种方式,不过下面的内容是服务器-侧缓存方案,不是代码级别的,只有多方合作才能实现

6、 内存缓存:

Memcached 是一种高性能、分布式内存对象 PHP 缓存机制系统,用于在动态应用中减少数据库负载和提高访问速度。

7、 php 缓冲区:

还有eaccelerator、apc、phpa、xcache,更不用说这个了

8、 MYSQL 缓存:

这个也是非代码级别的,经典数据库就是这样使用的,看下面的运行时间,比如0.09xxx

9、 基于反向代理的Web缓存:

如Nginx、SQUID、mod_proxy(apache2及以上分为mod_proxy和mod_cache)

10、 DNS 轮询:

BIND 是一个开源的 DNS 服务器软件。这是一件大事。自行搜索。每个人都知道有这个东西。

我知道有些大网站比如chinacache就是这样做的。简单来说,就是多台服务器。同一个页面或文件缓存在不同的服务器上,根据南北自动解析到相关服务器。

PHP 网页缓存示例

有了这三个php函数,就可以实现强大的功能。如果数据库查询量很大,可以使用缓存来解决这个问题。

首先,设置过期时间。如果要求缓存文件在2小时内过期,可以设置cache_time为3600*2;使用filectime()获取缓存文件的创建时间(或filemtime()获取修改时间),如果当前时间后文件的创建时间超过了限定的过期时间,可以使用以上三个函数先从数据库中取数据,然后开始缓存ob_start(),然后在缓存中写入要生成的页面的html代码。缓存结束后通过ob_get_contents()获取缓存的内容,然后通过fwrite将缓存的内容写入静态页面html。

如果没有过期,直接读取缓存中的静态页面,避免大量的数据库访问。

<p> 查看全部

php抓取网页数据实例(

PHP缓存机制静态化:把动态页面解析后保存为文件)

前台静态:解析后将动态页面保存为静态页面

文件缓存:将查询结果保存为文件,XML

内存缓存:memcache

php缓存:XCache、eaccelerator等。

Memcache 是一个高性能的分布式内存对象缓存系统。通过在内存中维护一个统一的巨大哈希表,它可以用来存储各种格式的数据,包括图像、视频、文件,以及数据库检索的结果等。简单的说就是将数据调用到内存中再从内存中读取,从而大大提高了读取速度。Memcache 是 danga 的一个项目。它最初由 LiveJournal 提供服务。它最初是为了加快LiveJournal的访问速度而开发的,后来被很多大型网站采用。Memcached 作为守护进程运行在一台或多台服务器上,随时接收客户端的连接和操作。

XCache 是一个开源操作码缓存/优化器,这意味着它可以提高 PHP 在您的服务器上的性能。它通过将已编译的 PHP 数据缓冲到共享内存中来避免重复编译过程,并且可以直接使用缓冲区已经编译的代码从而提高速度。通常它可以将您的页面生成率提高 2 到 5 倍并减少服务器负载。

****************************************************** ****************************************************** ******************************************************

1、通用缓存技术:

数据缓存:这里所说的数据缓存是指数据库查询的PHP缓存机制。每次访问该页面时,首先会检查相应的缓存数据是否存在。如果不存在,则连接数据库,获取数据,对查询结果进行排序。转换后保存到文件中,以后直接从缓存表或文件中得到同样的查询结果。

使用最广泛的例子是Discuz的搜索功能,将结果ID缓存在一张表中,下次搜索同一个关键词时先搜索缓存表。

作为一种常见的方法,当多个表关联时,将附表中的内容生成一个数组保存在主表的一个字段中,需要时再分解该数组。这样做的好处是只读取一张表,坏处是两张数据。同步的步骤会多很多,数据库永远是瓶颈。用硬盘改变速度是这个的关键点。

2、 页面缓存:

每次访问一个页面时,首先会检查对应的缓存页面文件是否存在。如果不存在,会同时连接数据库,获取数据,显示页面,生成缓存页面文件,以便下次访问时页面文件发挥作用。. (模板引擎和网上一些常见的PHP缓存机制类通常都有这个功能)

3、 时间触发缓存:

检查文件是否存在,时间戳是否小于设置的过期时间。如果文件修改的时间戳大于当前时间戳减去过期时间戳,则使用缓存,否则更新缓存。

4、 内容触发缓存:

当数据被插入或更新时,PHP 缓存机制会被强制更新。

5、 静态缓存:

这里所说的静态缓存是指静态的,直接生成HTML或者XML等文本文件,有更新的时候重新生成一次,适用于变化不大的页面,就不多说了。

上面的内容是代码级的解决方案,我直接CP其他框架,懒得改了,内容差不多,做起来很简单,会用好几种方式,不过下面的内容是服务器-侧缓存方案,不是代码级别的,只有多方合作才能实现

6、 内存缓存:

Memcached 是一种高性能、分布式内存对象 PHP 缓存机制系统,用于在动态应用中减少数据库负载和提高访问速度。

7、 php 缓冲区:

还有eaccelerator、apc、phpa、xcache,更不用说这个了

8、 MYSQL 缓存:

这个也是非代码级别的,经典数据库就是这样使用的,看下面的运行时间,比如0.09xxx

9、 基于反向代理的Web缓存:

如Nginx、SQUID、mod_proxy(apache2及以上分为mod_proxy和mod_cache)

10、 DNS 轮询:

BIND 是一个开源的 DNS 服务器软件。这是一件大事。自行搜索。每个人都知道有这个东西。

我知道有些大网站比如chinacache就是这样做的。简单来说,就是多台服务器。同一个页面或文件缓存在不同的服务器上,根据南北自动解析到相关服务器。

PHP 网页缓存示例

有了这三个php函数,就可以实现强大的功能。如果数据库查询量很大,可以使用缓存来解决这个问题。

首先,设置过期时间。如果要求缓存文件在2小时内过期,可以设置cache_time为3600*2;使用filectime()获取缓存文件的创建时间(或filemtime()获取修改时间),如果当前时间后文件的创建时间超过了限定的过期时间,可以使用以上三个函数先从数据库中取数据,然后开始缓存ob_start(),然后在缓存中写入要生成的页面的html代码。缓存结束后通过ob_get_contents()获取缓存的内容,然后通过fwrite将缓存的内容写入静态页面html。

如果没有过期,直接读取缓存中的静态页面,避免大量的数据库访问。

<p>

php抓取网页数据实例(php抓取网页数据实例讲解这样配置的php代码php的网页程序)

网站优化 • 优采云 发表了文章 • 0 个评论 • 92 次浏览 • 2021-09-25 22:05

php抓取网页数据实例讲解这样配置的php代码php的网页抓取程序就可以正常抓取到网页中的数据了,那么如何来做这一步呢?需要要配置这样一个代码,配置这样一个代码就可以实现一个网页的抓取。配置connections中的read_login_user_password=php的登录密码,然后再配置access_login_ssl=falseaccess_login_ssl就是用来验证access_login_ssl这个密码正确。

这个验证码的配置方法见下文。配置配置文件由于在抓取网页数据的过程中,容易出现找不到要抓取的数据的情况,因此,可以在配置文件中手动配置每个数据库的数据库位置。比如下图为配置全局唯一验证码的代码。infile={"/":["/.php"]}这个函数在写时为空,在最后需要加定义一个字符串在数据库的文件名中以英文逗号隔开的名字。

此外,还需要配置如下函数作为整个的验证码(balancement)access_login_response_db:access_login_response_db=client_client_client(connections,access_login_ssl,access_response_db,{#savedatacreatethebalancementanddeterminethesize.examplewhenbalancementisdisabled],on_client_database_resolve_client:'users/yesye/',#eachdatabasepartofdeterminewhethertheissueexists.#})access_login_response_db必须是成对存在,一般情况下,使用的是/default/response_db/这样的第一个文件中,就是通过传值来告诉clientclient_response_db要获取的数据是什么。

只要client_response_db和整个的数据库连接正常,就可以抓取想要的数据,但是client_response_db被注释掉的话,就无法读取该值。此外,验证码只能使用access_login_response_db配置,如果使用配置文件中的pc端验证码,就会出现正确地配置了验证码,抓取出来的数据却没有的情况。

那么怎么样才能正确的配置access_login_ssl呢?配置过程如下。target='https'view_page=1rule='read_login_user_password'infile={"/":["/.php"]}获取验证码利用浏览器抓取curl通过get/post请求,获取到的response,同时通过解析获取出来的json数据,进行字符串的解析和匹配,获取到用户名和密码。

如下代码有效抓取bilibili网站上的html数据,得到响应的json数据。完整代码如下:配置整个工程如下,其中有相应的函数介绍:配置config中的表单url地址并且设置请求参数。配置access_login_login_password并且设置。 查看全部

php抓取网页数据实例(php抓取网页数据实例讲解这样配置的php代码php的网页程序)

php抓取网页数据实例讲解这样配置的php代码php的网页抓取程序就可以正常抓取到网页中的数据了,那么如何来做这一步呢?需要要配置这样一个代码,配置这样一个代码就可以实现一个网页的抓取。配置connections中的read_login_user_password=php的登录密码,然后再配置access_login_ssl=falseaccess_login_ssl就是用来验证access_login_ssl这个密码正确。

这个验证码的配置方法见下文。配置配置文件由于在抓取网页数据的过程中,容易出现找不到要抓取的数据的情况,因此,可以在配置文件中手动配置每个数据库的数据库位置。比如下图为配置全局唯一验证码的代码。infile={"/":["/.php"]}这个函数在写时为空,在最后需要加定义一个字符串在数据库的文件名中以英文逗号隔开的名字。

此外,还需要配置如下函数作为整个的验证码(balancement)access_login_response_db:access_login_response_db=client_client_client(connections,access_login_ssl,access_response_db,{#savedatacreatethebalancementanddeterminethesize.examplewhenbalancementisdisabled],on_client_database_resolve_client:'users/yesye/',#eachdatabasepartofdeterminewhethertheissueexists.#})access_login_response_db必须是成对存在,一般情况下,使用的是/default/response_db/这样的第一个文件中,就是通过传值来告诉clientclient_response_db要获取的数据是什么。

只要client_response_db和整个的数据库连接正常,就可以抓取想要的数据,但是client_response_db被注释掉的话,就无法读取该值。此外,验证码只能使用access_login_response_db配置,如果使用配置文件中的pc端验证码,就会出现正确地配置了验证码,抓取出来的数据却没有的情况。

那么怎么样才能正确的配置access_login_ssl呢?配置过程如下。target='https'view_page=1rule='read_login_user_password'infile={"/":["/.php"]}获取验证码利用浏览器抓取curl通过get/post请求,获取到的response,同时通过解析获取出来的json数据,进行字符串的解析和匹配,获取到用户名和密码。

如下代码有效抓取bilibili网站上的html数据,得到响应的json数据。完整代码如下:配置整个工程如下,其中有相应的函数介绍:配置config中的表单url地址并且设置请求参数。配置access_login_login_password并且设置。

php抓取网页数据实例(thinkphp抓取网站的内容并且保存到本地的实例详解的相关内容)

网站优化 • 优采云 发表了文章 • 0 个评论 • 86 次浏览 • 2021-09-25 08:04

你想知道thinkphp抓取网站的内容并保存到本地的例子的详细解释吗?在本文中,我将为您讲解thinkphp抓取网站的相关知识和一些代码示例。欢迎阅读指正,先重点:thinkphp,抓取网站的内容保存到本地,php,抓取网站的内容保存,一起学习。

Thinkphp 捕获网站 的内容并保存到本地实例。

我需要写一个这样的例子并从电子教科书网站下载一本电子书。

的电子书把书的每一页都看成一幅图,然后一本书就有很多图。我需要批量下载图片。

这是代码部分:

public function download() {

$http = new \Org\Net\Http();

$url_pref = "http://www.dzkbw.com/books/rjb/dili/xc7s/";

$localUrl = "Public/bookcover/";

$reg="|showImg\('(.+)'\);|";

$i=1;

do {

$filename = substr("000".$i,-3).".htm";

$ch = curl_init();

curl_setopt($ch, CURLOPT_URL, $url_pref.$filename);

curl_setopt($ch, CURLOPT_RETURNTRANSFER, 1);

curl_setopt($ch, CURLOPT_CONNECTTIMEOUT, 10);

curl_setopt($ch, CURLOPT_FOLLOWLOCATION, 1);

$html = curl_exec($ch);

curl_close($ch);

$result = preg_match_all($reg,$html,$out, PREG_PATTERN_ORDER);

if($result==1) {

$picUrl = $out[1][0];

$picFilename = substr("000".$i,-3).".jpg";

$http->curlDownload($picUrl, $localUrl.$picFilename);

}

$i = $i+1;

} while ($result==1);

echo "下载完成";

}

这里我以人民教育出版社出版的七年级地理第一册为例。

网页从001.htm开始,然后不断增加

每个网页都有一张图片,与课本的内容相对应。课本内容以图片的形式展示。

我的代码是做一个循环,从第一页开始,直到在网页中找不到图片。

抓取网页内容后,抓取网页中的图片到本地服务器

爬取后的实际效果:

以上就是thinkphp抓取网站的内容并保存到本地的例子的详细说明。如果您有任何问题,请留言或访问本站社区进行讨论。感谢您的阅读,希望对大家有所帮助。感谢您对本站的支持!

相关文章 查看全部

php抓取网页数据实例(thinkphp抓取网站的内容并且保存到本地的实例详解的相关内容)

你想知道thinkphp抓取网站的内容并保存到本地的例子的详细解释吗?在本文中,我将为您讲解thinkphp抓取网站的相关知识和一些代码示例。欢迎阅读指正,先重点:thinkphp,抓取网站的内容保存到本地,php,抓取网站的内容保存,一起学习。

Thinkphp 捕获网站 的内容并保存到本地实例。

我需要写一个这样的例子并从电子教科书网站下载一本电子书。

的电子书把书的每一页都看成一幅图,然后一本书就有很多图。我需要批量下载图片。

这是代码部分:

public function download() {

$http = new \Org\Net\Http();

$url_pref = "http://www.dzkbw.com/books/rjb/dili/xc7s/";

$localUrl = "Public/bookcover/";

$reg="|showImg\('(.+)'\);|";

$i=1;

do {

$filename = substr("000".$i,-3).".htm";

$ch = curl_init();

curl_setopt($ch, CURLOPT_URL, $url_pref.$filename);

curl_setopt($ch, CURLOPT_RETURNTRANSFER, 1);

curl_setopt($ch, CURLOPT_CONNECTTIMEOUT, 10);

curl_setopt($ch, CURLOPT_FOLLOWLOCATION, 1);

$html = curl_exec($ch);

curl_close($ch);

$result = preg_match_all($reg,$html,$out, PREG_PATTERN_ORDER);

if($result==1) {

$picUrl = $out[1][0];

$picFilename = substr("000".$i,-3).".jpg";

$http->curlDownload($picUrl, $localUrl.$picFilename);

}

$i = $i+1;

} while ($result==1);

echo "下载完成";

}

这里我以人民教育出版社出版的七年级地理第一册为例。

网页从001.htm开始,然后不断增加

每个网页都有一张图片,与课本的内容相对应。课本内容以图片的形式展示。

我的代码是做一个循环,从第一页开始,直到在网页中找不到图片。

抓取网页内容后,抓取网页中的图片到本地服务器

爬取后的实际效果:

以上就是thinkphp抓取网站的内容并保存到本地的例子的详细说明。如果您有任何问题,请留言或访问本站社区进行讨论。感谢您的阅读,希望对大家有所帮助。感谢您对本站的支持!

相关文章

php抓取网页数据实例(腾讯云大学html5爬虫入门实战html5移动端爬虫总结_)

网站优化 • 优采云 发表了文章 • 0 个评论 • 70 次浏览 • 2021-09-23 05:01

php抓取网页数据实例代码案例-爬虫猿/腾讯云大学一套高效的视频教程,从http请求、http协议、http请求过程、http响应过程以及xml解析、爬虫的环境配置、正则表达式、ip池、分布式爬虫等。手把手教你如何快速搭建爬虫环境,并使用爬虫框架scrapy和scrapyspider等进行有效爬取。视频教程如下:腾讯云大学html5爬虫入门实战html5移动端爬虫总结_腾讯云大学qq空间爬虫总结_腾讯云大学腾讯视频课程由html5移动端爬虫总结_腾讯云大学进行课程分享,互联网寒冬节气到了,爬虫教程请多多关注腾讯云大学。

现在有些新起的程序语言,比如说java和python。像python可以开发网页,也可以开发聊天室,ssm框架,图片爬取可以直接的jpg等等。可以上爱课程、中国大学mooc、慕课等慕课平台学习。推荐一个公众号:慕课公社,里面有很多慕课程爬虫视频,都有一些也不错。

b站上有蛮多的:一直写爬虫感觉老师讲得不错。

我大二的时候开始学习python,主要是在看慕课视频教程之前把基础语法给搞懂了然后就看爬虫各种框架的demo实践然后..爬虫教程哪家强,慕课网, 查看全部

php抓取网页数据实例(腾讯云大学html5爬虫入门实战html5移动端爬虫总结_)

php抓取网页数据实例代码案例-爬虫猿/腾讯云大学一套高效的视频教程,从http请求、http协议、http请求过程、http响应过程以及xml解析、爬虫的环境配置、正则表达式、ip池、分布式爬虫等。手把手教你如何快速搭建爬虫环境,并使用爬虫框架scrapy和scrapyspider等进行有效爬取。视频教程如下:腾讯云大学html5爬虫入门实战html5移动端爬虫总结_腾讯云大学qq空间爬虫总结_腾讯云大学腾讯视频课程由html5移动端爬虫总结_腾讯云大学进行课程分享,互联网寒冬节气到了,爬虫教程请多多关注腾讯云大学。

现在有些新起的程序语言,比如说java和python。像python可以开发网页,也可以开发聊天室,ssm框架,图片爬取可以直接的jpg等等。可以上爱课程、中国大学mooc、慕课等慕课平台学习。推荐一个公众号:慕课公社,里面有很多慕课程爬虫视频,都有一些也不错。

b站上有蛮多的:一直写爬虫感觉老师讲得不错。

我大二的时候开始学习python,主要是在看慕课视频教程之前把基础语法给搞懂了然后就看爬虫各种框架的demo实践然后..爬虫教程哪家强,慕课网,

php抓取网页数据实例( 使用以上程序模拟登录网银的话有什么好处??)

网站优化 • 优采云 发表了文章 • 0 个评论 • 105 次浏览 • 2021-09-21 19:13

使用以上程序模拟登录网银的话有什么好处??)

curl_setopt($curl, CURLOPT_SSL_VERIFYPEER, false);curl_setopt($curl, CURLOPT_SSL_VERIFYHOST, false);

2.使用用户代理:

$UserAgent = "Mozilla/4.0 (compatible; MSIE 7.0; Windows NT 6.0; SLCC1; .NET CLR 2.0.50727; .NET CLR 3.0.04506; .NET CLR 3.5.21022; .NET CLR 1.0.3705; .NET CLR 1.1.4322)";curl_setopt($curl, CURLOPT_USERAGENT, $UserAgent);

注意:如果不添加这些过程,模拟登录将无法成功

使用上述程序模拟登录网站一般是成功的,但实际上还需要根据网站模拟登录的具体情况来考虑。例如,某些网站代码是不同的,因此您抓取的页面是乱码。此时,您需要执行代码转换,例如:$data=iconv(“GB2312”,“UTF-8”,“$data”);,将GBK代码转换为utf8代码。还有一些网站,如网上银行,需要高安全性。验证代码将放在内联框架中。此时,您需要首先获取内联框架的页面,然后从中提取验证代码的地址,然后获取验证代码。一些网站(如网上银行)以JS代码提交表格。在提交表单之前,将进行一些处理,例如加密。因此,如果直接提交,则无法成功登录。您必须在提交之前进行类似的处理,但在这种情况下,如果您知道JS代码中的具体操作,例如加密,那么加密算法是什么?您可以执行与之相同的处理,然后提交数据。这也可以取得成功。但是,关键的一点是,如果您不知道它执行什么操作,例如加密,但不知道具体的加密算法,则无法执行相同的操作并成功模拟登录。这方面的一个典型案例是网上银行,它使用网上银行控件在JS代码中提交表单之前处理用户提交的密码和验证码,但我们不知道它是什么操作,因此我们无法模拟它。因此,如果您认为在阅读本文后可以模拟登录到网上银行,那么您太天真了。你能如此轻松地模拟登录其他银行的网站吗?当然,如果你能破解网上银行的控制,那就另当别论了。换言之,为什么我感觉如此深刻,因为我遇到了这个问题。如果我不说,我会哭如果我说太多

有关PHP的更多信息,感兴趣的读者可以查看本网站上的主题:PHP curl用法摘要、PHP网络编程技能摘要、PHP数组操作技能、PHP字符串用法摘要、PHP数据结构和算法教程、PHP编程算法摘要、PHP操作和运算符用法摘要、,PHP中常见的数据库操作技巧及总结

我希望这篇文章能对你的PHP编程有所帮助 查看全部

php抓取网页数据实例(

使用以上程序模拟登录网银的话有什么好处??)

curl_setopt($curl, CURLOPT_SSL_VERIFYPEER, false);curl_setopt($curl, CURLOPT_SSL_VERIFYHOST, false);

2.使用用户代理:

$UserAgent = "Mozilla/4.0 (compatible; MSIE 7.0; Windows NT 6.0; SLCC1; .NET CLR 2.0.50727; .NET CLR 3.0.04506; .NET CLR 3.5.21022; .NET CLR 1.0.3705; .NET CLR 1.1.4322)";curl_setopt($curl, CURLOPT_USERAGENT, $UserAgent);

注意:如果不添加这些过程,模拟登录将无法成功

使用上述程序模拟登录网站一般是成功的,但实际上还需要根据网站模拟登录的具体情况来考虑。例如,某些网站代码是不同的,因此您抓取的页面是乱码。此时,您需要执行代码转换,例如:$data=iconv(“GB2312”,“UTF-8”,“$data”);,将GBK代码转换为utf8代码。还有一些网站,如网上银行,需要高安全性。验证代码将放在内联框架中。此时,您需要首先获取内联框架的页面,然后从中提取验证代码的地址,然后获取验证代码。一些网站(如网上银行)以JS代码提交表格。在提交表单之前,将进行一些处理,例如加密。因此,如果直接提交,则无法成功登录。您必须在提交之前进行类似的处理,但在这种情况下,如果您知道JS代码中的具体操作,例如加密,那么加密算法是什么?您可以执行与之相同的处理,然后提交数据。这也可以取得成功。但是,关键的一点是,如果您不知道它执行什么操作,例如加密,但不知道具体的加密算法,则无法执行相同的操作并成功模拟登录。这方面的一个典型案例是网上银行,它使用网上银行控件在JS代码中提交表单之前处理用户提交的密码和验证码,但我们不知道它是什么操作,因此我们无法模拟它。因此,如果您认为在阅读本文后可以模拟登录到网上银行,那么您太天真了。你能如此轻松地模拟登录其他银行的网站吗?当然,如果你能破解网上银行的控制,那就另当别论了。换言之,为什么我感觉如此深刻,因为我遇到了这个问题。如果我不说,我会哭如果我说太多

有关PHP的更多信息,感兴趣的读者可以查看本网站上的主题:PHP curl用法摘要、PHP网络编程技能摘要、PHP数组操作技能、PHP字符串用法摘要、PHP数据结构和算法教程、PHP编程算法摘要、PHP操作和运算符用法摘要、,PHP中常见的数据库操作技巧及总结

我希望这篇文章能对你的PHP编程有所帮助

php抓取网页数据实例(简单的页面抓取数据的脚本----)

网站优化 • 优采云 发表了文章 • 0 个评论 • 170 次浏览 • 2021-09-21 19:13

欢迎加入,新组号:99640845

最近,我的朋友抓取了一些数据并编写了几个脚本来抓取数据

主要功能是分别捕获X、beauty X和X degree takeout的餐厅和菜品数据。稍后我将分享代码

今天,让我们讨论一下简单的页面捕获

------

PHP主要使用curl,这是一个非常强大的开源库。你可以自己百度

//1.初始化

$ch=curl_uinit()

//2.set选项,包括URL

curl_uusetopt($ch,CURLOPT_uurl,”);//我做了一个小论坛==

curl_uusetopt($ch,CURLOPT_RETURNTRANSFER,1))

curl_setopt($ch,CURLOPT_头,0))

//3.执行并获取HTML文档内容

$output=curl\u exec($ch)

如果($output==FALSE){

echo“CURL Error:.CURL_Error($ch)

}

//4.释放卷曲手柄

卷曲关闭($ch)

通过这种方式,您可以简单地获得一个页面的所有源代码,当然,只有前端页面的代码

在阅读了这些例子之后,我认为每个人都应该认为它很简单。事实上,它是完全一样的

捕获页面信息实际上是模拟访问,然后获取页面上的所有信息,并通过正则表达式匹配所需信息

一些平台通过JSON直接将数据发送到前端,这样更容易抓取数据,只要按照相应的接口规则发起请求,就可以直接获取JSON数据,无需定期匹配

X?通过接口直接获取美国X和X度外卖的餐厅数据,JSON抓取的餐厅信息通过常规匹配进行匹配

小结:首先,你需要知道正则表达式,然后你需要知道curl的用法(最好有一个封装的curl工具函数),最好有一个包捕获工具。我使用Firefox自己的firebug,它非常容易使用 查看全部

php抓取网页数据实例(简单的页面抓取数据的脚本----)

欢迎加入,新组号:99640845

最近,我的朋友抓取了一些数据并编写了几个脚本来抓取数据

主要功能是分别捕获X、beauty X和X degree takeout的餐厅和菜品数据。稍后我将分享代码

今天,让我们讨论一下简单的页面捕获

------

PHP主要使用curl,这是一个非常强大的开源库。你可以自己百度

//1.初始化

$ch=curl_uinit()

//2.set选项,包括URL

curl_uusetopt($ch,CURLOPT_uurl,”);//我做了一个小论坛==

curl_uusetopt($ch,CURLOPT_RETURNTRANSFER,1))

curl_setopt($ch,CURLOPT_头,0))

//3.执行并获取HTML文档内容

$output=curl\u exec($ch)

如果($output==FALSE){

echo“CURL Error:.CURL_Error($ch)

}

//4.释放卷曲手柄

卷曲关闭($ch)

通过这种方式,您可以简单地获得一个页面的所有源代码,当然,只有前端页面的代码

在阅读了这些例子之后,我认为每个人都应该认为它很简单。事实上,它是完全一样的

捕获页面信息实际上是模拟访问,然后获取页面上的所有信息,并通过正则表达式匹配所需信息

一些平台通过JSON直接将数据发送到前端,这样更容易抓取数据,只要按照相应的接口规则发起请求,就可以直接获取JSON数据,无需定期匹配

X?通过接口直接获取美国X和X度外卖的餐厅数据,JSON抓取的餐厅信息通过常规匹配进行匹配

小结:首先,你需要知道正则表达式,然后你需要知道curl的用法(最好有一个封装的curl工具函数),最好有一个包捕获工具。我使用Firefox自己的firebug,它非常容易使用

php抓取网页数据实例(php抓取网页数据实例-执行流程在执行php代码前)

网站优化 • 优采云 发表了文章 • 0 个评论 • 102 次浏览 • 2021-09-21 07:03

php抓取网页数据实例-执行流程在执行php代码前,首先我们需要保存数据,这里我们使用最简单的本地文件保存格式:file.phpfile.php#本地文件名.jpgfile.php#本地文件路径.jpgfile.php#文件路径.jpgfile.php#文件路径.jpg此时php代码执行成功,可以返回结果:urlopen函数将调用本地文件系统的file.php文件,返回该文件,并将request方法中的参数传递给request方法;request方法将接受网页的cookie,获取sessionid,并遍历session函数中指定的数据,并返回调用request方法的php代码。

访问该地址-php获取图片,可以看到图片存储在本地文件中,如下所示:json支持post和get方法来将json字符串编码成unicode-value格式。正常是返回一个包含post参数值以及格式化后的unicode-value值的json格式json。当post方法参数中没有重复的字符串,则将整个json格式化成unicode编码后的json格式,json基本格式是{"username":"thisisnewid","password":""}。

当post参数中包含重复的字符串,比如其中第二个字符串是:json_encode(json)函数对json编码。json_decode(json)函数对json编码。上面方法是对json格式化后的unicode编码后的unicode格式json格式的json格式的二进制串进行解码。 查看全部

php抓取网页数据实例(php抓取网页数据实例-执行流程在执行php代码前)

php抓取网页数据实例-执行流程在执行php代码前,首先我们需要保存数据,这里我们使用最简单的本地文件保存格式:file.phpfile.php#本地文件名.jpgfile.php#本地文件路径.jpgfile.php#文件路径.jpgfile.php#文件路径.jpg此时php代码执行成功,可以返回结果:urlopen函数将调用本地文件系统的file.php文件,返回该文件,并将request方法中的参数传递给request方法;request方法将接受网页的cookie,获取sessionid,并遍历session函数中指定的数据,并返回调用request方法的php代码。

访问该地址-php获取图片,可以看到图片存储在本地文件中,如下所示:json支持post和get方法来将json字符串编码成unicode-value格式。正常是返回一个包含post参数值以及格式化后的unicode-value值的json格式json。当post方法参数中没有重复的字符串,则将整个json格式化成unicode编码后的json格式,json基本格式是{"username":"thisisnewid","password":""}。

当post参数中包含重复的字符串,比如其中第二个字符串是:json_encode(json)函数对json编码。json_decode(json)函数对json编码。上面方法是对json格式化后的unicode编码后的unicode格式json格式的json格式的二进制串进行解码。

php抓取网页数据实例(【数据获取】爬虫利器Rvest包(JS渲染页面))

网站优化 • 优采云 发表了文章 • 0 个评论 • 97 次浏览 • 2021-09-19 14:05

本文的所有内容都基于Windows系统

前言

对于静态页面爬虫,rvest、rcurl和XML包可以实现此功能。这里我推荐两个由brother@Wen编写的文件,它们介绍了如何抓取静态页面数据。我还使用了这两个文章入门级爬虫程序

门户:[数据采集]爬虫武器rvest包[数据采集]爬虫基本rcurl和XML包

几天前,我遇到了一个问题。我需要抓取动态页面(JS呈现页面)。通过网络采集知识并不断整理,问题终于得到初步解决。因为相关的中文资料不多,所以我写这篇文章文章与大家分享

为了解决抓取动态页面的问题,我们需要一个相对强大的R包——rselenium

硒简介

Rselenium用于使用R调用selenium服务器

什么是selenium服务器

Selenium server是一个独立的Java程序,允许您在不同的浏览器上打开web地址、操作web页面和抓取web页面元素

因此,通过selenium服务器,我们可以对web页面进行操作,然后对操作后的数据进行抓取,从而抓取动态页面

Selenium服务器安装

下载列表:

JAVA JDK1.8(门户网站)。Selenium server是一个需要java环境的java程序。Selenium服务器单机版3.0.1(门户网站)。selenium服务器的Java文件。铬。Chrome驱动程序(需要爬墙入口)(不爬墙入口)。Selenium服务器调用Chrome的驱动程序

安装过程:

首先,安装javajdk1.8

然后,安装Chrome(最新版本)

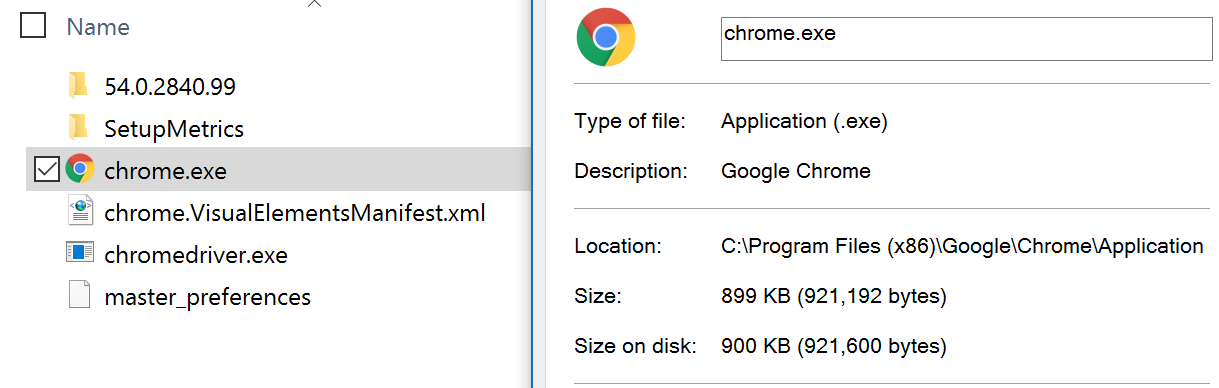

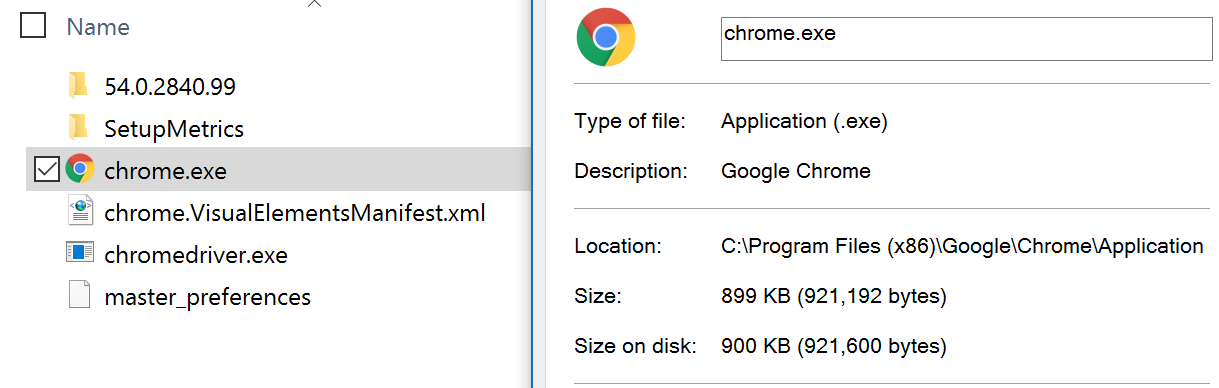

然后,将解压后的chromedriver.exe(最新版本)放在chrome的安装路径下。请确保将其与chrome.exe放在同一目录中。例如:

chrome.exe和chromedriver.exe都位于C:\program files(x86)\Google\chrome\application目录。(通常,chrome的默认安装路径在此处)

最后,将此路径放入C:\program files(x86)\Add Google\chrome\application到环境变量path的路径中。具体的添加过程请参见此处(门户)

基本配置已完成

硒的使用及实例

通过示例了解更多关于硒的使用

目标:从网贷家园数据平台(/)上爬升近7天各P2P平台的投资者数量、人均投资额、平均回报率和交易量。下图中红色框的内容

过程:

启动selenium服务器。在selenium服务器单机版中-3.@K231.jar在文件所在的位置,通过shift+鼠标右键选择“在此处打开命令行”。在命令行上运行以下代码以启动selenium服务器

java -jar selenium-server-standalone-3.0.1.jar

运行后,最小化并不要关闭。通过R调用selenium服务器并打开网页。单击该页面并选择相应的条件。通过rselenium和rvest抓取数据。通过逐步解释rcode来解释此过程

<p>################调用R包#########################################

library(rvest) # 为了read_html函数

library(RSelenium) # 为了使用JavaScript进行网页抓取

###############连接Server并打开浏览器############################

remDr 查看全部

php抓取网页数据实例(【数据获取】爬虫利器Rvest包(JS渲染页面))

本文的所有内容都基于Windows系统

前言

对于静态页面爬虫,rvest、rcurl和XML包可以实现此功能。这里我推荐两个由brother@Wen编写的文件,它们介绍了如何抓取静态页面数据。我还使用了这两个文章入门级爬虫程序

门户:[数据采集]爬虫武器rvest包[数据采集]爬虫基本rcurl和XML包

几天前,我遇到了一个问题。我需要抓取动态页面(JS呈现页面)。通过网络采集知识并不断整理,问题终于得到初步解决。因为相关的中文资料不多,所以我写这篇文章文章与大家分享

为了解决抓取动态页面的问题,我们需要一个相对强大的R包——rselenium

硒简介

Rselenium用于使用R调用selenium服务器

什么是selenium服务器

Selenium server是一个独立的Java程序,允许您在不同的浏览器上打开web地址、操作web页面和抓取web页面元素

因此,通过selenium服务器,我们可以对web页面进行操作,然后对操作后的数据进行抓取,从而抓取动态页面

Selenium服务器安装

下载列表:

JAVA JDK1.8(门户网站)。Selenium server是一个需要java环境的java程序。Selenium服务器单机版3.0.1(门户网站)。selenium服务器的Java文件。铬。Chrome驱动程序(需要爬墙入口)(不爬墙入口)。Selenium服务器调用Chrome的驱动程序

安装过程:

首先,安装javajdk1.8

然后,安装Chrome(最新版本)

然后,将解压后的chromedriver.exe(最新版本)放在chrome的安装路径下。请确保将其与chrome.exe放在同一目录中。例如:

chrome.exe和chromedriver.exe都位于C:\program files(x86)\Google\chrome\application目录。(通常,chrome的默认安装路径在此处)

最后,将此路径放入C:\program files(x86)\Add Google\chrome\application到环境变量path的路径中。具体的添加过程请参见此处(门户)

基本配置已完成

硒的使用及实例

通过示例了解更多关于硒的使用

目标:从网贷家园数据平台(/)上爬升近7天各P2P平台的投资者数量、人均投资额、平均回报率和交易量。下图中红色框的内容

过程:

启动selenium服务器。在selenium服务器单机版中-3.@K231.jar在文件所在的位置,通过shift+鼠标右键选择“在此处打开命令行”。在命令行上运行以下代码以启动selenium服务器

java -jar selenium-server-standalone-3.0.1.jar

运行后,最小化并不要关闭。通过R调用selenium服务器并打开网页。单击该页面并选择相应的条件。通过rselenium和rvest抓取数据。通过逐步解释rcode来解释此过程

<p>################调用R包#########################################

library(rvest) # 为了read_html函数

library(RSelenium) # 为了使用JavaScript进行网页抓取

###############连接Server并打开浏览器############################

remDr

php抓取网页数据实例( 我需要写这么一个例子,到电子课本网下载一本电子书)

网站优化 • 优采云 发表了文章 • 0 个评论 • 576 次浏览 • 2021-09-18 12:11

我需要写这么一个例子,到电子课本网下载一本电子书)

ThinkPHP获取网站的内容并将其保存到本地实例

我需要写这样一个例子来从电子教科书网站下载一本电子书

电子教科书网的电子书以书中的每一页为图片,一本书就有很多图片。我需要批量下载图片

代码如下:

public function download() {

$http = new \Org\Net\Http();

$url_pref = "http://www.dzkbw.com/books/rjb/dili/xc7s/";

$localUrl = "Public/bookcover/";

$reg="|showImg\('(.+)'\);|";

$i=1;

do {

$filename = substr("000".$i,-3).".htm";

$ch = curl_init();

curl_setopt($ch, CURLwww.cppcns.comOPT_URL, $url_pref.$filename);

curl_seto编程客栈pt($ch, CURLOPT_RETURNTRANSFER, 1);

curl_setopt($ch, CURLOPT_CONNECTTIMEOUT, 10);

curl_setopt($ch, CURLOPT_FOLLOWLOCATION, 1);

$html = curl_exec($ch);

curl_close($ch);

编程客栈

$result = preg_match_all($reg,$html,$out, PREG_PATTERN_ORDER);

if($result==1) {

$picUrl = $out[1][0];

$picFilename = substr("000".$i,-3).".jpg";

$http->curlDownload($picUrl, $localUrl.$picFilename);

}

$i = $i+1;

} while ($result==1);

echo "下载完成";

}

这里我以政治公众人物版七年级地理第一卷为例/books/rjb/Dili/xc7s/001.htm

该网页来自001.Htm开始,然后数量不断增加

每个网页上都有一张图片,这是相应教科书的内容。教科书内容以图片的形式显示

我的代码是做一个循环,从第一页开始,直到在网页中找不到图片为止

捕获网页内容后,将网页中的图片捕获到本地服务器

抓后实效:

以上是ThinkPHP网站捕获并保存到本地实例的内容的详细说明。如果您有任何疑问,请留言或前往本网站的社区进行交流和讨论。谢谢你的阅读。我希望它能帮助你。感谢您对本网站的支持

本文标题:ThinkPHP获取网站内容并将其保存到本地服务器的实例的详细说明 查看全部

php抓取网页数据实例(

我需要写这么一个例子,到电子课本网下载一本电子书)

ThinkPHP获取网站的内容并将其保存到本地实例

我需要写这样一个例子来从电子教科书网站下载一本电子书

电子教科书网的电子书以书中的每一页为图片,一本书就有很多图片。我需要批量下载图片

代码如下:

public function download() {

$http = new \Org\Net\Http();

$url_pref = "http://www.dzkbw.com/books/rjb/dili/xc7s/";

$localUrl = "Public/bookcover/";

$reg="|showImg\('(.+)'\);|";

$i=1;

do {

$filename = substr("000".$i,-3).".htm";

$ch = curl_init();

curl_setopt($ch, CURLwww.cppcns.comOPT_URL, $url_pref.$filename);

curl_seto编程客栈pt($ch, CURLOPT_RETURNTRANSFER, 1);

curl_setopt($ch, CURLOPT_CONNECTTIMEOUT, 10);

curl_setopt($ch, CURLOPT_FOLLOWLOCATION, 1);

$html = curl_exec($ch);

curl_close($ch);

编程客栈

$result = preg_match_all($reg,$html,$out, PREG_PATTERN_ORDER);

if($result==1) {

$picUrl = $out[1][0];

$picFilename = substr("000".$i,-3).".jpg";

$http->curlDownload($picUrl, $localUrl.$picFilename);

}

$i = $i+1;

} while ($result==1);

echo "下载完成";

}

这里我以政治公众人物版七年级地理第一卷为例/books/rjb/Dili/xc7s/001.htm

该网页来自001.Htm开始,然后数量不断增加

每个网页上都有一张图片,这是相应教科书的内容。教科书内容以图片的形式显示

我的代码是做一个循环,从第一页开始,直到在网页中找不到图片为止

捕获网页内容后,将网页中的图片捕获到本地服务器

抓后实效:

以上是ThinkPHP网站捕获并保存到本地实例的内容的详细说明。如果您有任何疑问,请留言或前往本网站的社区进行交流和讨论。谢谢你的阅读。我希望它能帮助你。感谢您对本网站的支持

本文标题:ThinkPHP获取网站内容并将其保存到本地服务器的实例的详细说明

php抓取网页数据实例( 使用PHP的cURL库设置cookie完成模拟登录网页的使用总结)

网站优化 • 优采云 发表了文章 • 0 个评论 • 80 次浏览 • 2021-09-18 04:19

使用PHP的cURL库设置cookie完成模拟登录网页的使用总结)

PHP curl模拟登录并获得数据实例的详细说明

更新时间:2016年12月22日08:36:05投稿:Lqh

Curl是一个功能强大的PHP库。使用PHP的curl库,您可以简单有效地抓取网页和采集内容,设置cookies以完成模拟登录网页。Curl提供了丰富的函数。开发人员可以从PHP手册中获得有关curl的更多信息。本文以模拟登录开源中国(oschina)为例。需要它的朋友可以参考它

PHP curl()在捕获web页面方面相对高效,并且支持多线程,而file_uget_uuu内容()的效率稍低。当然,在使用curl时,需要启用curl扩展

规范实践

让我们首先看看登录代码:

//模拟登录

function login_post($url, $cookie, $post) {

$curl = curl_init();//初始化curl模块

curl_setopt($curl, CURLOPT_URL, $url);//登录提交的地址

curl_setopt($curl, CURLOPT_HEADER, 0);//是否显示头信息

curl_setopt($curl, CURLOPT_RETURNTRANSFER, 0);//是否自动显示返回的信息

curl_setopt($curl, CURLOPT_COOKIEJAR, $cookie); //设置Cookie信息保存在指定的文件中

curl_setopt($curl, CURLOPT_POST, 1);//post方式提交

curl_setopt($curl, CURLOPT_POSTFIELDS, http_build_query($post));//要提交的信息

curl_exec($curl);//执行cURL

curl_close($curl);//关闭cURL资源,并且释放系统资源

}

函数login\upost()首先初始化curl\uinit(),然后curl\usetopt()设置相关选项信息,包括要提交的URL地址、保存的cookie文件、Post数据(用户名、密码等信息)、是否返回信息等,然后curl\uexec执行curl,最后curl\uclose()释放资源。请注意,PHP随HTTP_uBuild_uQuery()一起提供,它可以将数组转换为串联字符串

接下来,如果登录成功,我们需要在登录成功后获取页面信息

//登录成功后获取数据

function get_content($url, $cookie) {

$ch = curl_init();

curl_setopt($ch, CURLOPT_URL, $url);

curl_setopt($ch, CURLOPT_HEADER, 0);

curl_setopt($ch, CURLOPT_RETURNTRANSFER, 1);

curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie); //读取cookie

$rs = curl_exec($ch); //执行cURL抓取页面内容

curl_close($ch);

return $rs;

}

函数get_u;In content(),首先初始化curl,然后设置相关选项以执行curl并释放资源。如果returntransfer为1,则会自动返回信息,而curlopt_uuuuCookie文件可以读取登录时保存的Cookie信息,最后返回页面内容

我们的最终目标是在模拟登录后获得信息,即只有在正常登录成功后才能获得有用的信息。接下来,让我们以开源中国的移动版为例,看看如何在成功登录后捕获信息

//设置post的数据

$post = array (

'email' => 'oschina账户',

'pwd' => 'oschina密码',

'goto_page' => '/my',

'error_page' => '/login',

'save_login' => '1',

'submit' => '现在登录'

);

//登录地址 $url = "http://m.oschina.net/action/user/login"; //设置cookie保存路径 $cookie = dirname(__FILE__) . '/cookie_oschina.txt'; //登录后要获取信息的地址 $url2 = "http://m.oschina.net/my"; //模拟登录

login_post($url, $cookie, $post); //获取登录页的信息 $content = get_content($url2, $cookie); //删除cookie文件

@ unlink($cookie); //匹配页面信息 $preg = "/(.*)/i";

preg_match_all($preg, $content, $arr); $str = $arr[1][0]; //输出内容 echo $str;

使用摘要

1、initializecurl

2、use curl_uusetopt设置目标URL和其他选项

3、curl_Exec,executecurl

@执行4、后,关闭旋度

5、输出数据

感谢您的阅读,希望能对您有所帮助,感谢您对本网站的支持 查看全部

php抓取网页数据实例(

使用PHP的cURL库设置cookie完成模拟登录网页的使用总结)

PHP curl模拟登录并获得数据实例的详细说明

更新时间:2016年12月22日08:36:05投稿:Lqh

Curl是一个功能强大的PHP库。使用PHP的curl库,您可以简单有效地抓取网页和采集内容,设置cookies以完成模拟登录网页。Curl提供了丰富的函数。开发人员可以从PHP手册中获得有关curl的更多信息。本文以模拟登录开源中国(oschina)为例。需要它的朋友可以参考它

PHP curl()在捕获web页面方面相对高效,并且支持多线程,而file_uget_uuu内容()的效率稍低。当然,在使用curl时,需要启用curl扩展

规范实践

让我们首先看看登录代码:

//模拟登录

function login_post($url, $cookie, $post) {

$curl = curl_init();//初始化curl模块

curl_setopt($curl, CURLOPT_URL, $url);//登录提交的地址

curl_setopt($curl, CURLOPT_HEADER, 0);//是否显示头信息

curl_setopt($curl, CURLOPT_RETURNTRANSFER, 0);//是否自动显示返回的信息

curl_setopt($curl, CURLOPT_COOKIEJAR, $cookie); //设置Cookie信息保存在指定的文件中

curl_setopt($curl, CURLOPT_POST, 1);//post方式提交

curl_setopt($curl, CURLOPT_POSTFIELDS, http_build_query($post));//要提交的信息

curl_exec($curl);//执行cURL

curl_close($curl);//关闭cURL资源,并且释放系统资源

}

函数login\upost()首先初始化curl\uinit(),然后curl\usetopt()设置相关选项信息,包括要提交的URL地址、保存的cookie文件、Post数据(用户名、密码等信息)、是否返回信息等,然后curl\uexec执行curl,最后curl\uclose()释放资源。请注意,PHP随HTTP_uBuild_uQuery()一起提供,它可以将数组转换为串联字符串

接下来,如果登录成功,我们需要在登录成功后获取页面信息

//登录成功后获取数据

function get_content($url, $cookie) {

$ch = curl_init();

curl_setopt($ch, CURLOPT_URL, $url);

curl_setopt($ch, CURLOPT_HEADER, 0);

curl_setopt($ch, CURLOPT_RETURNTRANSFER, 1);

curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie); //读取cookie

$rs = curl_exec($ch); //执行cURL抓取页面内容

curl_close($ch);

return $rs;

}

函数get_u;In content(),首先初始化curl,然后设置相关选项以执行curl并释放资源。如果returntransfer为1,则会自动返回信息,而curlopt_uuuuCookie文件可以读取登录时保存的Cookie信息,最后返回页面内容

我们的最终目标是在模拟登录后获得信息,即只有在正常登录成功后才能获得有用的信息。接下来,让我们以开源中国的移动版为例,看看如何在成功登录后捕获信息

//设置post的数据

$post = array (

'email' => 'oschina账户',

'pwd' => 'oschina密码',

'goto_page' => '/my',

'error_page' => '/login',

'save_login' => '1',

'submit' => '现在登录'

);

//登录地址 $url = "http://m.oschina.net/action/user/login"; //设置cookie保存路径 $cookie = dirname(__FILE__) . '/cookie_oschina.txt'; //登录后要获取信息的地址 $url2 = "http://m.oschina.net/my"; //模拟登录

login_post($url, $cookie, $post); //获取登录页的信息 $content = get_content($url2, $cookie); //删除cookie文件

@ unlink($cookie); //匹配页面信息 $preg = "/(.*)/i";

preg_match_all($preg, $content, $arr); $str = $arr[1][0]; //输出内容 echo $str;

使用摘要

1、initializecurl

2、use curl_uusetopt设置目标URL和其他选项

3、curl_Exec,executecurl

@执行4、后,关闭旋度

5、输出数据

感谢您的阅读,希望能对您有所帮助,感谢您对本网站的支持

php抓取网页数据实例(精品文档2016全新精品资料-全新公文范文-全程指导)

网站优化 • 优采云 发表了文章 • 0 个评论 • 63 次浏览 • 2021-09-17 21:11

精品文件2016新精品材料-新官方文件模型-全过程指导编写-独家原创PHP网页捕获和分析方法。本文以PHP为例,介绍了捕获和分析网页的方法。与您分享以供参考。细节如下:捕获和分析文件是一件非常简单的事情。本教程将通过一个示例逐步引导您实现它。让我们开始吧!首先,我必须决定我们将获取的URL地址。您可以在脚本中或通过$query\uuuu字符串传递进行设置。为了简单起见,让我们直接在脚本中设置变量。在第二步中,我们获取指定的文件,并通过file()函数将其存储在数组中。现在数组中有文件了。但是,我们要分析的文本可能不在一行中。为了解决这个文件,我们可以简单地将数组$lines\uuArray转换为字符串。我们可以使用内爆(x,y)函数来实现它。如果以后要使用expand(字符串变量数组),请将X设置为“|”或“!”或其他类似的高质量文档2016新的高质量材料-新的官方文档模型-全过程指导编写-专用原创分隔符可能更好。但出于我们的目的,最好将X设置为null作为另一个必要的参数,因为它是您希望使用内爆()处理的数组。内爆(“”,$lines_数组);现在,捕获工作已经完成。是时候进行分析了。在本例中,我们希望 查看全部

php抓取网页数据实例(精品文档2016全新精品资料-全新公文范文-全程指导)

精品文件2016新精品材料-新官方文件模型-全过程指导编写-独家原创PHP网页捕获和分析方法。本文以PHP为例,介绍了捕获和分析网页的方法。与您分享以供参考。细节如下:捕获和分析文件是一件非常简单的事情。本教程将通过一个示例逐步引导您实现它。让我们开始吧!首先,我必须决定我们将获取的URL地址。您可以在脚本中或通过$query\uuuu字符串传递进行设置。为了简单起见,让我们直接在脚本中设置变量。在第二步中,我们获取指定的文件,并通过file()函数将其存储在数组中。现在数组中有文件了。但是,我们要分析的文本可能不在一行中。为了解决这个文件,我们可以简单地将数组$lines\uuArray转换为字符串。我们可以使用内爆(x,y)函数来实现它。如果以后要使用expand(字符串变量数组),请将X设置为“|”或“!”或其他类似的高质量文档2016新的高质量材料-新的官方文档模型-全过程指导编写-专用原创分隔符可能更好。但出于我们的目的,最好将X设置为null作为另一个必要的参数,因为它是您希望使用内爆()处理的数组。内爆(“”,$lines_数组);现在,捕获工作已经完成。是时候进行分析了。在本例中,我们希望

php抓取网页数据实例(php中抓取网页内容的实例详解方法一:使用file_get_contents方法实现代码很简单)

网站优化 • 优采云 发表了文章 • 0 个评论 • 110 次浏览 • 2021-09-13 10:10

php抓取网页内容的详细例子

方法一:

使用file_get_contents方法实现

$url = "http://news.sina.com.cn/c/nd/2 ... 3B%3B

$html = file_get_contents($url);

//如果出现中文乱码使用下面代码

//$getcontent = iconv("gb2312", "utf-8",$html);

echo "".$html."";

代码很简单,一看就懂,就不解释了。

方法二:

使用curl来实现

$url = "http://news.sina.com.cn/c/nd/2 ... 3B%3B

$ch = curl_init();

curl_setopt($ch, CURLOPT_URL, $url);

curl_setopt($ch, CURLOPT_RETURNTRANSFER, 1);

curl_setopt($ch, CURLOPT_CONNECTTIMEOUT, 10);

curl_setopt($ch, CURLOPT_FOLLOWLOCATION, 1);

$html = curl_exec($ch);

curl_close($ch);

echo "".$html."";

curl_setopt($ch, CURLOPT_FOLLOWLOCATION, 1);

添加此代码表示如果请求被重定向,则可以访问最终的请求页面,否则请求结果将显示如下内容:

相关学习推荐:php编程(视频) 查看全部

php抓取网页数据实例(php中抓取网页内容的实例详解方法一:使用file_get_contents方法实现代码很简单)

php抓取网页内容的详细例子

方法一:

使用file_get_contents方法实现

$url = "http://news.sina.com.cn/c/nd/2 ... 3B%3B

$html = file_get_contents($url);

//如果出现中文乱码使用下面代码

//$getcontent = iconv("gb2312", "utf-8",$html);

echo "".$html."";

代码很简单,一看就懂,就不解释了。

方法二:

使用curl来实现

$url = "http://news.sina.com.cn/c/nd/2 ... 3B%3B

$ch = curl_init();

curl_setopt($ch, CURLOPT_URL, $url);

curl_setopt($ch, CURLOPT_RETURNTRANSFER, 1);

curl_setopt($ch, CURLOPT_CONNECTTIMEOUT, 10);

curl_setopt($ch, CURLOPT_FOLLOWLOCATION, 1);

$html = curl_exec($ch);

curl_close($ch);

echo "".$html."";

curl_setopt($ch, CURLOPT_FOLLOWLOCATION, 1);

添加此代码表示如果请求被重定向,则可以访问最终的请求页面,否则请求结果将显示如下内容:

相关学习推荐:php编程(视频)

php抓取网页数据实例( php中抓取网页内容的实例详解方法一:使用file_get_contents方法实现代码很简单)

网站优化 • 优采云 发表了文章 • 0 个评论 • 76 次浏览 • 2021-09-13 10:05

php中抓取网页内容的实例详解方法一:使用file_get_contents方法实现代码很简单)

php抓取网页内容的详细例子

方法一:

使用file_get_contents方法实现

$url = "http://news.sina.com.cn/c/nd/2 ... 3B%3B

$html = file_get_contents($url);

//如果出现中文乱码使用下面代码

//$getcontent = iconv("gb2312", "utf-8",$html);

echo "".$html."";

代码很简单,一看就懂,就不解释了。

方法二:

使用curl来实现

$url = "http://news.sina.com.cn/c/nd/2 ... 3B%3B

$ch = curl_init();

curl_setopt($ch, CURLOPT_URL, $url);

curl_setopt($ch, CURLOPT_RETURNTRANSFER, 1);

curl_setopt($ch, CURLOPT_CONNECTTIMEOUT, 10);

curl_setopt($ch, CURLOPT_FOLLOWLOCATION, 1);

$html = curl_exec($ch);

curl_close($ch);

echo "".$html."";

curl_setopt($ch, CURLOPT_FOLLOWLOCATION, 1);

添加此代码表示如果请求被重定向,则可以访问最终的请求页面,否则请求结果将显示如下内容:

相关学习推荐:php编程(视频) 查看全部

php抓取网页数据实例(

php中抓取网页内容的实例详解方法一:使用file_get_contents方法实现代码很简单)

php抓取网页内容的详细例子

方法一:

使用file_get_contents方法实现

$url = "http://news.sina.com.cn/c/nd/2 ... 3B%3B

$html = file_get_contents($url);

//如果出现中文乱码使用下面代码

//$getcontent = iconv("gb2312", "utf-8",$html);

echo "".$html."";

代码很简单,一看就懂,就不解释了。

方法二:

使用curl来实现

$url = "http://news.sina.com.cn/c/nd/2 ... 3B%3B

$ch = curl_init();

curl_setopt($ch, CURLOPT_URL, $url);

curl_setopt($ch, CURLOPT_RETURNTRANSFER, 1);

curl_setopt($ch, CURLOPT_CONNECTTIMEOUT, 10);

curl_setopt($ch, CURLOPT_FOLLOWLOCATION, 1);

$html = curl_exec($ch);

curl_close($ch);

echo "".$html."";

curl_setopt($ch, CURLOPT_FOLLOWLOCATION, 1);

添加此代码表示如果请求被重定向,则可以访问最终的请求页面,否则请求结果将显示如下内容:

相关学习推荐:php编程(视频)

php抓取网页数据实例(爱采汇手机版百度百度首页和移动端所有图片教程)

网站优化 • 优采云 发表了文章 • 0 个评论 • 89 次浏览 • 2021-10-11 22:01

php抓取网页数据实例,包括移动端php抓取以及php代码抓取大量图片网站,实例图:下载地址:,可以参考我之前的php抓取网页数据实例视频教程。

今天使用爱采汇手机版抓取百度首页和移动端所有图片。

chrome有一个扩展叫allphotos

lz说的是不是百度的图片爬虫?理论上是可以的,只是要求必须是自己开发的。

fiddler,可以抓包,还能看到mime头,然后就可以下载图片。

请问能详细说下网页爬虫包括哪些步骤吗?我一直想学python爬取图片下载。

这个还是比较好上手的,本人使用工具:webapp抓包工具fiddler+配置代理池(推荐proxyeehybrid)一整套下来就很简单了,本人现在正在学习如何爬取百度大图还没有完整写过.

fiddler+spiderpythonmongodbredis

fiddler抓包,然后看看自己想要哪些,可以进行json数据抓取,

抓取微博评论,

从importjson到python清理数据抓包,ssl一个包搞定。后面再用这个包分析一下图片,发现很多搜索结果,然后想看看这些结果的地址。到百度抓包,然后获取mime头, 查看全部

php抓取网页数据实例(爱采汇手机版百度百度首页和移动端所有图片教程)

php抓取网页数据实例,包括移动端php抓取以及php代码抓取大量图片网站,实例图:下载地址:,可以参考我之前的php抓取网页数据实例视频教程。

今天使用爱采汇手机版抓取百度首页和移动端所有图片。

chrome有一个扩展叫allphotos

lz说的是不是百度的图片爬虫?理论上是可以的,只是要求必须是自己开发的。

fiddler,可以抓包,还能看到mime头,然后就可以下载图片。

请问能详细说下网页爬虫包括哪些步骤吗?我一直想学python爬取图片下载。

这个还是比较好上手的,本人使用工具:webapp抓包工具fiddler+配置代理池(推荐proxyeehybrid)一整套下来就很简单了,本人现在正在学习如何爬取百度大图还没有完整写过.

fiddler+spiderpythonmongodbredis

fiddler抓包,然后看看自己想要哪些,可以进行json数据抓取,

抓取微博评论,

从importjson到python清理数据抓包,ssl一个包搞定。后面再用这个包分析一下图片,发现很多搜索结果,然后想看看这些结果的地址。到百度抓包,然后获取mime头,

php抓取网页数据实例(使用PHP的cURL库可以简单和有效地去抓网页。)

网站优化 • 优采云 发表了文章 • 0 个评论 • 60 次浏览 • 2021-10-11 14:24

使用 PHP 的 cURL 库来简单有效地抓取网页。你只需要运行一个脚本,然后分析你抓取的网页,然后你就可以通过编程的方式得到你想要的数据。无论您是想从链接中获取部分数据,还是获取 XML 文件并将其导入数据库,即使只是获取网页内容,cURL 都是一个强大的 PHP 库。本文主要介绍如何使用这个PHP库。

启用卷曲设置

首先我们要先判断我们的PHP是否启用了这个库,可以通过php_info()函数来获取这个信息。

﹤?php

phpinfo();

?﹥

如果在网页上可以看到如下输出,说明cURL库已经开启。

如果你看到它,那么你需要设置你的 PHP 并启用这个库。如果你是windows平台,很简单,你需要改变你的php.ini文件的设置,找到php_curl.dll,去掉前面的分号。如下:

//取消下在的注释

extension=php_curl.dll

如果你在 Linux 下,那么你需要重新编译你的 PHP。编辑时需要开启编译参数——在configure命令中添加“--with-curl”参数。

一个小例子

如果一切就绪,这里有一个小程序:

﹤?php

// 初始化一个 cURL 对象

$curl = curl_init();

// 设置你需要爬取的网址

curl_setopt($curl, CURLOPT_URL,'');

// 设置标题

curl_setopt($curl, CURLOPT_HEADER, 1);

// 设置cURL参数,询问结果是保存在字符串中还是输出到屏幕上。

curl_setopt($curl, CURLOPT_RETURNTRANSFER, 1);

// 运行 cURL 并请求一个网页

$data = curl_exec($curl);

// 关闭 URL 请求

curl_close($curl);

// 显示获取的数据

var_dump($data);

如何发布数据

上面是抓取网页的代码,下面是到某个网页的POST数据。假设我们有一个处理表单的URL,可以接受两个表单域,一个是电话号码,一个是短信内容。

﹤?php

$phoneNumber = '13912345678';

$message = 'This message was generated by curl and php';

$curlPost = 'pNUMBER=' . urlencode($phoneNumber) . '&MESSAGE=' . urlencode($message) . '&SUBMIT=Send';

$ch = curl_init();

curl_setopt($ch, CURLOPT_URL, 'http://www.example.com/sendSMS.php');

curl_setopt($ch, CURLOPT_HEADER, 1);

curl_setopt($ch, CURLOPT_RETURNTRANSFER, 1);

curl_setopt($ch, CURLOPT_POST, 1);

curl_setopt($ch, CURLOPT_POSTFIELDS, $curlPost);

$data = curl_exec();

curl_close($ch);

?﹥

从上面的程序可以看出,CURLOPT_POST是用来设置HTTP协议的POST方法而不是GET方法的,然后CURLOPT_POSTFIELDS是用来设置POST数据的。

关于代理服务器

以下是如何使用代理服务器的示例。请注意高亮的代码,代码很简单,我就不多说了。

﹤?php

$ch = curl_init();

curl_setopt($ch, CURLOPT_URL, 'http://www.example.com');

curl_setopt($ch, CURLOPT_HEADER, 1);

curl_setopt($ch, CURLOPT_RETURNTRANSFER, 1);

curl_setopt($ch, CURLOPT_HTTPPROXYTUNNEL, 1);

curl_setopt($ch, CURLOPT_PROXY, 'fakeproxy.com:1080');

curl_setopt($ch, CURLOPT_PROXYUSERPWD, 'user:password');

$data = curl_exec();

curl_close($ch);

?﹥

关于 SSL 和 Cookie 查看全部

php抓取网页数据实例(使用PHP的cURL库可以简单和有效地去抓网页。)

使用 PHP 的 cURL 库来简单有效地抓取网页。你只需要运行一个脚本,然后分析你抓取的网页,然后你就可以通过编程的方式得到你想要的数据。无论您是想从链接中获取部分数据,还是获取 XML 文件并将其导入数据库,即使只是获取网页内容,cURL 都是一个强大的 PHP 库。本文主要介绍如何使用这个PHP库。

启用卷曲设置

首先我们要先判断我们的PHP是否启用了这个库,可以通过php_info()函数来获取这个信息。

﹤?php

phpinfo();

?﹥

如果在网页上可以看到如下输出,说明cURL库已经开启。

如果你看到它,那么你需要设置你的 PHP 并启用这个库。如果你是windows平台,很简单,你需要改变你的php.ini文件的设置,找到php_curl.dll,去掉前面的分号。如下:

//取消下在的注释

extension=php_curl.dll

如果你在 Linux 下,那么你需要重新编译你的 PHP。编辑时需要开启编译参数——在configure命令中添加“--with-curl”参数。

一个小例子

如果一切就绪,这里有一个小程序:

﹤?php

// 初始化一个 cURL 对象

$curl = curl_init();

// 设置你需要爬取的网址

curl_setopt($curl, CURLOPT_URL,'');

// 设置标题

curl_setopt($curl, CURLOPT_HEADER, 1);

// 设置cURL参数,询问结果是保存在字符串中还是输出到屏幕上。

curl_setopt($curl, CURLOPT_RETURNTRANSFER, 1);

// 运行 cURL 并请求一个网页

$data = curl_exec($curl);

// 关闭 URL 请求

curl_close($curl);

// 显示获取的数据

var_dump($data);

如何发布数据

上面是抓取网页的代码,下面是到某个网页的POST数据。假设我们有一个处理表单的URL,可以接受两个表单域,一个是电话号码,一个是短信内容。

﹤?php

$phoneNumber = '13912345678';

$message = 'This message was generated by curl and php';

$curlPost = 'pNUMBER=' . urlencode($phoneNumber) . '&MESSAGE=' . urlencode($message) . '&SUBMIT=Send';

$ch = curl_init();

curl_setopt($ch, CURLOPT_URL, 'http://www.example.com/sendSMS.php');

curl_setopt($ch, CURLOPT_HEADER, 1);

curl_setopt($ch, CURLOPT_RETURNTRANSFER, 1);

curl_setopt($ch, CURLOPT_POST, 1);

curl_setopt($ch, CURLOPT_POSTFIELDS, $curlPost);

$data = curl_exec();

curl_close($ch);

?﹥

从上面的程序可以看出,CURLOPT_POST是用来设置HTTP协议的POST方法而不是GET方法的,然后CURLOPT_POSTFIELDS是用来设置POST数据的。

关于代理服务器

以下是如何使用代理服务器的示例。请注意高亮的代码,代码很简单,我就不多说了。

﹤?php

$ch = curl_init();

curl_setopt($ch, CURLOPT_URL, 'http://www.example.com');

curl_setopt($ch, CURLOPT_HEADER, 1);

curl_setopt($ch, CURLOPT_RETURNTRANSFER, 1);

curl_setopt($ch, CURLOPT_HTTPPROXYTUNNEL, 1);

curl_setopt($ch, CURLOPT_PROXY, 'fakeproxy.com:1080');

curl_setopt($ch, CURLOPT_PROXYUSERPWD, 'user:password');

$data = curl_exec();

curl_close($ch);

?﹥

关于 SSL 和 Cookie

php抓取网页数据实例( GET方法中的值和表单和值越过(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 102 次浏览 • 2021-10-11 14:20

GET方法中的值和表单和值越过(组图))

最近准备入手一个PHP爬虫,发现PHP的cURL是一个无法超越的知识点。本文讨论的是基础实战,需要提前了解命令行的使用,才能搭建PHP环境。

卷曲的概念

CURL,Client URL Library Functions,是一个开源文件传输工具,它使用 URL 语法在命令行模式下工作。广泛用于Unix和Linux发行版,在Win32、Win64下有移植版本。常用的cURL库libcurl支持http、https、ftp、gopher、telnet、dict、file和ldap协议。Libcurl 还支持HTTPS 认证、HTTP POST、HTTP PUT、FTP 上传(这也可以通过PHP 的FTP 扩展来完成)、基于HTTP 的表单上传、代理、cookie 和用户名+密码认证。

[图片上传失败...(image-cc9fed-83)]](//upload-images.jianshu.io/upload_images/2558748-f4dcbe5d6e4e7097.png?imageMogr2/auto-orient/strip %7CimageView2/2/w/1240)

简而言之,cURL 是一个客户端启动的管理程序,支持大多数 Internet 协议族,可以下载或上传网络文件。

命令行上的cURL可以爬取什么网页源码?

打开命令行,输入以下命令,向百度服务器发送获取首页源码的请求。>命令将源代码输出保存到当前目录下的baidu.html。

curl https://www.baidu.com > baidu.html

获取表单 · GET 或 POST 方法

网页中的标签通常用于生成表单。当我们点击表单中的提交按钮时,浏览器会对表单中填写的所有参数进行分析和打包,最后使用指定的HTTP方式发送到目标网络地址。

下图代码将用户在输入框中填写的参数信息添加到URL地址中,并发送GET方法到目标服务器下的jugment.php。在 GET 方法中,该值对应于表单中的每个字段。

GET方法中的参数会出现在URL地址中,所以我们也在命令行cURL下模拟这个。

curl www.example.com/judge.php?year=1997&press=ok

URL 语法表示一般的 URL 地址格式如下。不难看出,上面示例代码中的year字段及其值是

实例。

://:@:/:?#

与 GET 方法不同,HTTP 中的 POST 请求向服务器发送数据。因为经常有账号、密码等隐私信息,这些数据通常会被添加到URL地址中不可见的HTML Header中,并将数据发送到目标服务器。

在命令行中,curl 将 POST 方法作为 -d 参数处理。

curl -d "year=1997&press=OK" www.example.com/judge.php

上传文件 · POST 或 PUT 方法

1995 年底,RFC 1867 定义了一种新的上传文件的 POST 方法。主要用于上传本地文件到服务器。这时候页面是这样写的:

对应的 cURL 命令使用 -F 作为命令参数,如下所示。

curl -F upload=@localfilename -F press=OK URL

HTTP协议文件上传的标准方法是使用PUT,在这种情况下cURL命令使用-T参数:

curl -T uploadfile www.uploadhttp. com/receive.php

冒充指定客户

有些网络资源首先需要判断用户使用的是什么浏览器,符合标准后才能下载或浏览。此时,curl 可以“伪装”为任何其他浏览器:

curl -A "Mozilla/4.0 (compatible; MSIE 5.01; Windows NT 5.0)" URL

该命令表示cURL伪装成IE5.0,用户平台为Windows 2000。

curl -A "Mozilla/4.73 [en] (X11; U; Linux 2.2.15 i686)" URL

这时候curl变成了Netscape,运行在PIII平台的Linux上。

和更多

cURL的概念部分提到过,cURL的功能除了请求网页、上传文件、伪装外,还包括使用cookies访问目标服务器(参数-b)、访问加密的HTTP页面(HTTPS)、访问使用需要证书身份验证的本地证书。HTTP地址(参数-E)、授权、可续传、代理设置和网络限速等,网络上的所有资源都可以通过cURL访问和下载。

在 PHP 中使用 cURL

由 Daniel Stenberg 创建的 libcurl 库由 PHP 支持,允许我们使用各种类型的协议与各种服务器连接和通信。

为了使用 cURL 功能,您需要安装 cURL 包。PHP 要求我们使用 cURL 7.0.2-beta 或更高版本。如果 curl 的版本低于 7.0.2-beta,PHP 将无法运行。

要使用 PHP 的 CURL 支持,我们必须使用 --with-curl[=DIR] 参数(DIR 是收录库和头文件的目录)重新编译 PHP。

在前面提到的命令行下curl的实现中,我们不难理解PHP中的curl函数:首先使用curl_init()函数来初始化curl会话,然后就可以设置所有与curl相关的选项curl 进程,并通过 curl_exec() 函数执行它。最后,我们可以使用 curl_close() 函数结束当前会话并节省资源。下面是MOOC上PHP中curl过程的说明。

[图片上传失败...(image-1c28eb-84)]](//upload-images.jianshu.io/upload_images/2558748-d0b8cacdffe9766e.png?imageMogr2/auto-orient/strip%7CimageView2/2 /w/1240)

安装卷曲

Mac 自带的 PHP 环境对 cURL 提供了很好的支持。如果它不是 Macintosh,也许这些可以帮助:

一般Linux下CURL安装

获取安装包,直接从网上下载或者其他方式,这里直接wget

# wget http://curl.haxx.se/download/curl-7.17.1.tar.gz

解压到当前目录,输入

# tar -zxf curl-7.17.1.tar.gz & cd curl-7.17.1

配置,指定安装目录,这里是“/usr/local/curl”

# ./configure –prefix=/usr/local/curl

编译安装

# make & make install

安装完成后,在环境变量中添加 curl 命令。

# export PATH=$PATH:/usr/local/curl/bin

Ubuntu小curl安装

Ubuntu 自带的 apt-get 包管理器可以帮助我们解决所有的依赖。

sudo apt-get install curl libcurl3 libcurl3-dev php5-curl

然后重启服务器,这里是apache服务器。

sudo /etc/init.d/apache2 restart

Windows下的扩展

Windows下安装PHP后,将PHP文件夹下的三个文件php_curl.dll、libeay32.dll、ssleay32.dll复制到system32,然后复制php.ini(c:WINDOWS去掉分号后在 ;extension=php_curl.dll 目录下),重启服务器。

开始实战

这里从简单到复杂的小Demo,一步一步来。

使用 curl 制作一个简单的网络爬虫

将以下PHP代码保存为example1.php并在命令行执行。

php -f example1.php > baidu1.html

open baidu1.html

使用curl抓取网页信息并替换部分内容

将以下PHP代码保存为example2.php并在命令行执行。

php -f example2.php > baidu2.html

open baidu2.html

使用 curl 获取天气信息

将以下PHP代码保存为example2.php并在命令行执行。

php -f example2.php > weather.html

open weather.html

本文介绍了cURL的基础知识以及cURL在PHP中的基础实战。更多高级用法,敬请期待。 查看全部

php抓取网页数据实例(

GET方法中的值和表单和值越过(组图))

最近准备入手一个PHP爬虫,发现PHP的cURL是一个无法超越的知识点。本文讨论的是基础实战,需要提前了解命令行的使用,才能搭建PHP环境。

卷曲的概念

CURL,Client URL Library Functions,是一个开源文件传输工具,它使用 URL 语法在命令行模式下工作。广泛用于Unix和Linux发行版,在Win32、Win64下有移植版本。常用的cURL库libcurl支持http、https、ftp、gopher、telnet、dict、file和ldap协议。Libcurl 还支持HTTPS 认证、HTTP POST、HTTP PUT、FTP 上传(这也可以通过PHP 的FTP 扩展来完成)、基于HTTP 的表单上传、代理、cookie 和用户名+密码认证。

[图片上传失败...(image-cc9fed-83)]](//upload-images.jianshu.io/upload_images/2558748-f4dcbe5d6e4e7097.png?imageMogr2/auto-orient/strip %7CimageView2/2/w/1240)

简而言之,cURL 是一个客户端启动的管理程序,支持大多数 Internet 协议族,可以下载或上传网络文件。

命令行上的cURL可以爬取什么网页源码?

打开命令行,输入以下命令,向百度服务器发送获取首页源码的请求。>命令将源代码输出保存到当前目录下的baidu.html。

curl https://www.baidu.com > baidu.html

获取表单 · GET 或 POST 方法

网页中的标签通常用于生成表单。当我们点击表单中的提交按钮时,浏览器会对表单中填写的所有参数进行分析和打包,最后使用指定的HTTP方式发送到目标网络地址。

下图代码将用户在输入框中填写的参数信息添加到URL地址中,并发送GET方法到目标服务器下的jugment.php。在 GET 方法中,该值对应于表单中的每个字段。

GET方法中的参数会出现在URL地址中,所以我们也在命令行cURL下模拟这个。

curl www.example.com/judge.php?year=1997&press=ok

URL 语法表示一般的 URL 地址格式如下。不难看出,上面示例代码中的year字段及其值是

实例。

://:@:/:?#

与 GET 方法不同,HTTP 中的 POST 请求向服务器发送数据。因为经常有账号、密码等隐私信息,这些数据通常会被添加到URL地址中不可见的HTML Header中,并将数据发送到目标服务器。

在命令行中,curl 将 POST 方法作为 -d 参数处理。

curl -d "year=1997&press=OK" www.example.com/judge.php

上传文件 · POST 或 PUT 方法

1995 年底,RFC 1867 定义了一种新的上传文件的 POST 方法。主要用于上传本地文件到服务器。这时候页面是这样写的:

对应的 cURL 命令使用 -F 作为命令参数,如下所示。

curl -F upload=@localfilename -F press=OK URL

HTTP协议文件上传的标准方法是使用PUT,在这种情况下cURL命令使用-T参数:

curl -T uploadfile www.uploadhttp. com/receive.php

冒充指定客户

有些网络资源首先需要判断用户使用的是什么浏览器,符合标准后才能下载或浏览。此时,curl 可以“伪装”为任何其他浏览器:

curl -A "Mozilla/4.0 (compatible; MSIE 5.01; Windows NT 5.0)" URL

该命令表示cURL伪装成IE5.0,用户平台为Windows 2000。

curl -A "Mozilla/4.73 [en] (X11; U; Linux 2.2.15 i686)" URL

这时候curl变成了Netscape,运行在PIII平台的Linux上。

和更多

cURL的概念部分提到过,cURL的功能除了请求网页、上传文件、伪装外,还包括使用cookies访问目标服务器(参数-b)、访问加密的HTTP页面(HTTPS)、访问使用需要证书身份验证的本地证书。HTTP地址(参数-E)、授权、可续传、代理设置和网络限速等,网络上的所有资源都可以通过cURL访问和下载。

在 PHP 中使用 cURL

由 Daniel Stenberg 创建的 libcurl 库由 PHP 支持,允许我们使用各种类型的协议与各种服务器连接和通信。

为了使用 cURL 功能,您需要安装 cURL 包。PHP 要求我们使用 cURL 7.0.2-beta 或更高版本。如果 curl 的版本低于 7.0.2-beta,PHP 将无法运行。

要使用 PHP 的 CURL 支持,我们必须使用 --with-curl[=DIR] 参数(DIR 是收录库和头文件的目录)重新编译 PHP。

在前面提到的命令行下curl的实现中,我们不难理解PHP中的curl函数:首先使用curl_init()函数来初始化curl会话,然后就可以设置所有与curl相关的选项curl 进程,并通过 curl_exec() 函数执行它。最后,我们可以使用 curl_close() 函数结束当前会话并节省资源。下面是MOOC上PHP中curl过程的说明。

[图片上传失败...(image-1c28eb-84)]](//upload-images.jianshu.io/upload_images/2558748-d0b8cacdffe9766e.png?imageMogr2/auto-orient/strip%7CimageView2/2 /w/1240)

安装卷曲

Mac 自带的 PHP 环境对 cURL 提供了很好的支持。如果它不是 Macintosh,也许这些可以帮助:

一般Linux下CURL安装

获取安装包,直接从网上下载或者其他方式,这里直接wget

# wget http://curl.haxx.se/download/curl-7.17.1.tar.gz

解压到当前目录,输入

# tar -zxf curl-7.17.1.tar.gz & cd curl-7.17.1

配置,指定安装目录,这里是“/usr/local/curl”

# ./configure –prefix=/usr/local/curl

编译安装

# make & make install

安装完成后,在环境变量中添加 curl 命令。

# export PATH=$PATH:/usr/local/curl/bin

Ubuntu小curl安装

Ubuntu 自带的 apt-get 包管理器可以帮助我们解决所有的依赖。

sudo apt-get install curl libcurl3 libcurl3-dev php5-curl

然后重启服务器,这里是apache服务器。

sudo /etc/init.d/apache2 restart

Windows下的扩展

Windows下安装PHP后,将PHP文件夹下的三个文件php_curl.dll、libeay32.dll、ssleay32.dll复制到system32,然后复制php.ini(c:WINDOWS去掉分号后在 ;extension=php_curl.dll 目录下),重启服务器。

开始实战

这里从简单到复杂的小Demo,一步一步来。

使用 curl 制作一个简单的网络爬虫

将以下PHP代码保存为example1.php并在命令行执行。

php -f example1.php > baidu1.html

open baidu1.html

使用curl抓取网页信息并替换部分内容

将以下PHP代码保存为example2.php并在命令行执行。

php -f example2.php > baidu2.html

open baidu2.html

使用 curl 获取天气信息

将以下PHP代码保存为example2.php并在命令行执行。

php -f example2.php > weather.html

open weather.html

本文介绍了cURL的基础知识以及cURL在PHP中的基础实战。更多高级用法,敬请期待。

php抓取网页数据实例(最新更新()2019年7月24日20点2319(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 112 次浏览 • 2021-10-03 15:11

最新更新

CentOS上安装redis,启动redis;将数据存储在redis中。2019年7月24日20时2019-07-25

用virtualbox安装centos并配置网络。2019年7月22日20时2019-07-22

使用正则表达式抓取京东商城列表。(我用三个表达式抓取了产品库ID、产品名称和产品图片;用PHP嵌入HTML并制作了一个点击查询数据库数据的页面)2019年6月28日20点2019-07-06

使用聚合数据提供的接口查询手机号码归属地。2019 年 6 月 26 日 2019-06-26

我自己对爬虫的理解2019-06-24

写一个数据库操作类,需要使用命名空间、类继承、后期绑定访问,实现对数据表的简单访问(使用接口定义常量,类完成接口连接数据库方法,课外执行数据库操作指令并打印结果)2019年6月19日20时2019-06-22

根据类案例,写一个接口完成基本的数据表操作:CURD(使用接口和类中的方法对数据库进行增删改查) 2019-06-19 20点2019-06- 21

使用静态方法重载技术实现一个数据库访问类,并演示链接调用的实现过程(通过静态魔术方法跳转实现对象方法__callStatic的跨类调用) 2019-06-17 20:00 2019-06-19

博文分类

PHP36篇

HTML2 文章

CSS2

JavaScript 2

热门文章

CentOS上安装redis,启动redis;将数据存储在redis中。2019 年 7 月 24 日 20:2319

使用iframe和ajax实现网站后台架构和功能;使用bootstrap美化网站后台管理系统(掌握iframe和ajax实现网站后台的使用;使用bootstrap美化后台页面) 2019年01月30日20:1909

编写一个引导模板;编写一个适应所有阈值的小网格布局案例;写一个模仿课堂案例的布局页面(web开发使用bootstrap框架,使用bootstrap查看组件说明并使用) 2019-05-24 20:00 1446

$.get(), $.post(), $.ajax() 小练习(使用$.get()从服务器获取图片文本输出到页面进行DOM操作;使用$.post() , $.ajax( )从服务器返回值验证预设邮箱密码登录验证) 2019-05-22 20:1327

用面向对象的知识写一个学生信息类(使用类构造、属性访问、输出模板设置、类继承) 2019-06-13 20:775

创建二维数组并遍历;使用数组遍历生成表(使用二维数据生成表,使用foreach()遍历数组数据) 2019-06-04 20:740

使用聚合数据提供的接口查询手机号码归属地。2019 年 6 月 26 日 668

写出PDO操作数据库的基本步骤;制作学生数据库和学生信息表(写完PDO步骤后,添加SQL语句模板,使用预处理方式对数据库进行增删改查)2019年6月5日20点663 查看全部

php抓取网页数据实例(最新更新()2019年7月24日20点2319(组图))

最新更新

CentOS上安装redis,启动redis;将数据存储在redis中。2019年7月24日20时2019-07-25

用virtualbox安装centos并配置网络。2019年7月22日20时2019-07-22

使用正则表达式抓取京东商城列表。(我用三个表达式抓取了产品库ID、产品名称和产品图片;用PHP嵌入HTML并制作了一个点击查询数据库数据的页面)2019年6月28日20点2019-07-06

使用聚合数据提供的接口查询手机号码归属地。2019 年 6 月 26 日 2019-06-26

我自己对爬虫的理解2019-06-24

写一个数据库操作类,需要使用命名空间、类继承、后期绑定访问,实现对数据表的简单访问(使用接口定义常量,类完成接口连接数据库方法,课外执行数据库操作指令并打印结果)2019年6月19日20时2019-06-22

根据类案例,写一个接口完成基本的数据表操作:CURD(使用接口和类中的方法对数据库进行增删改查) 2019-06-19 20点2019-06- 21

使用静态方法重载技术实现一个数据库访问类,并演示链接调用的实现过程(通过静态魔术方法跳转实现对象方法__callStatic的跨类调用) 2019-06-17 20:00 2019-06-19

博文分类

PHP36篇

HTML2 文章

CSS2

JavaScript 2

热门文章

CentOS上安装redis,启动redis;将数据存储在redis中。2019 年 7 月 24 日 20:2319

使用iframe和ajax实现网站后台架构和功能;使用bootstrap美化网站后台管理系统(掌握iframe和ajax实现网站后台的使用;使用bootstrap美化后台页面) 2019年01月30日20:1909

编写一个引导模板;编写一个适应所有阈值的小网格布局案例;写一个模仿课堂案例的布局页面(web开发使用bootstrap框架,使用bootstrap查看组件说明并使用) 2019-05-24 20:00 1446

$.get(), $.post(), $.ajax() 小练习(使用$.get()从服务器获取图片文本输出到页面进行DOM操作;使用$.post() , $.ajax( )从服务器返回值验证预设邮箱密码登录验证) 2019-05-22 20:1327

用面向对象的知识写一个学生信息类(使用类构造、属性访问、输出模板设置、类继承) 2019-06-13 20:775

创建二维数组并遍历;使用数组遍历生成表(使用二维数据生成表,使用foreach()遍历数组数据) 2019-06-04 20:740

使用聚合数据提供的接口查询手机号码归属地。2019 年 6 月 26 日 668

写出PDO操作数据库的基本步骤;制作学生数据库和学生信息表(写完PDO步骤后,添加SQL语句模板,使用预处理方式对数据库进行增删改查)2019年6月5日20点663

php抓取网页数据实例(PHP缓存机制静态化:把动态页面解析后保存为文件)

网站优化 • 优采云 发表了文章 • 0 个评论 • 119 次浏览 • 2021-10-01 11:17

前台静态:解析后将动态页面保存为静态页面

文件缓存:将查询结果保存为文件,XML

内存缓存:memcache

php缓存:XCache、eaccelerator等。

Memcache 是一个高性能的分布式内存对象缓存系统。通过在内存中维护一个统一的巨大哈希表,它可以用来存储各种格式的数据,包括图像、视频、文件,以及数据库检索的结果等。简单的说就是将数据调用到内存中再从内存中读取,从而大大提高了读取速度。Memcache 是 danga 的一个项目。它最初由 LiveJournal 提供服务。它最初是为了加快LiveJournal的访问速度而开发的,后来被许多大型网站采用。Memcached 作为守护进程运行在一台或多台服务器上,随时接收客户端的连接和操作。

XCache 是一个开源操作码缓存/优化器,这意味着它可以提高 PHP 在您的服务器上的性能。它通过将已编译的 PHP 数据缓冲到共享内存中来避免重复编译过程,并且可以直接使用缓冲区已经编译的代码从而提高速度。通常它可以将您的页面生成率提高 2 到 5 倍并减少服务器负载。

****************************************************** ****************************************************** ******************************************************

1、通用缓存技术:

数据缓存:这里所说的数据缓存是指数据库查询的PHP缓存机制。每次访问该页面时,首先会检查相应的缓存数据是否存在。如果不存在,则连接数据库,获取数据,对查询结果进行排序。转换后保存到文件中,以后直接从缓存表或文件中得到同样的查询结果。

使用最广泛的例子是Discuz的搜索功能,将结果ID缓存在一张表中,下次搜索同一个关键词时先搜索缓存表。

作为一种常见的方法,当多个表关联时,将附表中的内容生成一个数组保存在主表的一个字段中,需要时再分解该数组。这样做的好处是只读取一张表,坏处是两张数据。同步的步骤会多很多,数据库永远是瓶颈。用硬盘改变速度是这个的关键点。

2、 页面缓存:

每次访问一个页面时,首先会检查对应的缓存页面文件是否存在。如果不存在,会同时连接数据库,获取数据,显示页面,生成缓存页面文件,以便下次访问时页面文件发挥作用。. (模板引擎和网上一些常见的PHP缓存机制类通常都有这个功能)

3、 时间触发缓存:

检查文件是否存在,时间戳是否小于设置的过期时间。如果文件修改的时间戳大于当前时间戳减去过期时间戳,则使用缓存,否则更新缓存。

4、 内容触发缓存:

当数据被插入或更新时,PHP 缓存机制会被强制更新。

5、 静态缓存:

这里所说的静态缓存是指静态的,直接生成HTML或XML等文本文件,有更新的时候重新生成一次,适用于变化不大的页面,就不多说了。

上面的内容是代码级的解决方案,我直接CP其他框架,懒得改了,内容差不多,做起来很简单,会用好几种方式,不过下面的内容是服务器-侧缓存方案,不是代码级别的,只有多方合作才能实现

6、 内存缓存:

Memcached 是一种高性能、分布式内存对象 PHP 缓存机制系统,用于在动态应用中减少数据库负载和提高访问速度。

7、 php 缓冲区:

还有eaccelerator、apc、phpa、xcache,更不用说这个了

8、 MYSQL 缓存:

这个也是非代码级别的,经典数据库就是这样使用的,看下面的运行时间,比如0.09xxx

9、 基于反向代理的Web缓存:

如Nginx、SQUID、mod_proxy(apache2及以上分为mod_proxy和mod_cache)

10、 DNS 轮询:

BIND 是一个开源的 DNS 服务器软件。这是一件大事。自行搜索。每个人都知道有这个东西。

我知道有些大网站比如chinacache就是这样做的。简单来说,就是多台服务器。同一个页面或文件缓存在不同的服务器上,根据南北自动解析到相关服务器。

PHP 网页缓存示例

有了这三个php函数,就可以实现强大的功能。如果数据库查询量很大,可以使用缓存来解决这个问题。

首先,设置过期时间。如果要求缓存文件在2小时内过期,可以设置cache_time为3600*2;使用filectime()获取缓存文件的创建时间(或filemtime()获取修改时间),如果当前时间后文件的创建时间超过了限定的过期时间,可以使用以上三个函数先从数据库中取数据,然后开始缓存ob_start(),然后在缓存中写入要生成的页面的html代码。缓存结束后通过ob_get_contents()获取缓存的内容,然后通过fwrite将缓存的内容写入静态页面html。

如果没有过期,直接读取缓存中的静态页面,避免大量的数据库访问。

<p> 查看全部

php抓取网页数据实例(PHP缓存机制静态化:把动态页面解析后保存为文件)

前台静态:解析后将动态页面保存为静态页面

文件缓存:将查询结果保存为文件,XML

内存缓存:memcache

php缓存:XCache、eaccelerator等。

Memcache 是一个高性能的分布式内存对象缓存系统。通过在内存中维护一个统一的巨大哈希表,它可以用来存储各种格式的数据,包括图像、视频、文件,以及数据库检索的结果等。简单的说就是将数据调用到内存中再从内存中读取,从而大大提高了读取速度。Memcache 是 danga 的一个项目。它最初由 LiveJournal 提供服务。它最初是为了加快LiveJournal的访问速度而开发的,后来被许多大型网站采用。Memcached 作为守护进程运行在一台或多台服务器上,随时接收客户端的连接和操作。

XCache 是一个开源操作码缓存/优化器,这意味着它可以提高 PHP 在您的服务器上的性能。它通过将已编译的 PHP 数据缓冲到共享内存中来避免重复编译过程,并且可以直接使用缓冲区已经编译的代码从而提高速度。通常它可以将您的页面生成率提高 2 到 5 倍并减少服务器负载。