php抓取网页所有图片

php抓取网页所有图片( 可爱的Python(哲思社区)插图版,文字版[PDF])

网站优化 • 优采云 发表了文章 • 0 个评论 • 57 次浏览 • 2022-03-24 09:05

可爱的Python(哲思社区)插图版,文字版[PDF])

可爱的Python(哲学社区)图解版、文字版[PDF]

现在网上有很多用python2写的爬虫爬取网页图片的例子,但是不适合新手(新手使用python3环境,不兼容python2),

所以我用Python3语法写了一个简单的抓取网页图片的例子,希望对大家有帮助,也希望大家批评指正。

import urllib.request

import re

import os

import urllib

#根据给定的网址来获取网页详细信息,得到的html就是网页的源代码

def getHtml(url):

page = urllib.request.urlopen(url)

html = page.read()

return html.decode('UTF-8')

def getImg(html):

reg = r'src="(.+?\.jpg)" pic_ext'

imgre = re.compile(reg)

imglist = imgre.findall(html)#表示在整个网页中过滤出所有图片的地址,放在imglist中

x = 0

path = 'D:\\test'

# 将图片保存到D:\\test文件夹中,如果没有test文件夹则创建

if not os.path.isdir(path):

os.makedirs(path)

paths = path+'\\' #保存在test路径下

for imgurl in imglist:

urllib.request.urlretrieve(imgurl,'{0}{1}.jpg'.format(paths,x)) #打开imglist中保存的图片网址,并下载图片保存在本地,format格式化字符串

x = x + 1

return imglist

html = getHtml("http://tieba.baidu.com/p/2460150866")#获取该网址网页详细信息,得到的html就是网页的源代码

print (getImg(html)) #从网页源代码中分析并下载保存图片

以上就是本文的全部内容,希望对大家的学习有所帮助,也希望大家多多支持古谷店计划。

转载请注明: 谷谷店程序 » Python3简单爬虫爬取网页图片代码示例 查看全部

php抓取网页所有图片(

可爱的Python(哲思社区)插图版,文字版[PDF])

可爱的Python(哲学社区)图解版、文字版[PDF]

现在网上有很多用python2写的爬虫爬取网页图片的例子,但是不适合新手(新手使用python3环境,不兼容python2),

所以我用Python3语法写了一个简单的抓取网页图片的例子,希望对大家有帮助,也希望大家批评指正。

import urllib.request

import re

import os

import urllib

#根据给定的网址来获取网页详细信息,得到的html就是网页的源代码

def getHtml(url):

page = urllib.request.urlopen(url)

html = page.read()

return html.decode('UTF-8')

def getImg(html):

reg = r'src="(.+?\.jpg)" pic_ext'

imgre = re.compile(reg)

imglist = imgre.findall(html)#表示在整个网页中过滤出所有图片的地址,放在imglist中

x = 0

path = 'D:\\test'

# 将图片保存到D:\\test文件夹中,如果没有test文件夹则创建

if not os.path.isdir(path):

os.makedirs(path)

paths = path+'\\' #保存在test路径下

for imgurl in imglist:

urllib.request.urlretrieve(imgurl,'{0}{1}.jpg'.format(paths,x)) #打开imglist中保存的图片网址,并下载图片保存在本地,format格式化字符串

x = x + 1

return imglist

html = getHtml("http://tieba.baidu.com/p/2460150866";)#获取该网址网页详细信息,得到的html就是网页的源代码

print (getImg(html)) #从网页源代码中分析并下载保存图片

以上就是本文的全部内容,希望对大家的学习有所帮助,也希望大家多多支持古谷店计划。

转载请注明: 谷谷店程序 » Python3简单爬虫爬取网页图片代码示例

php抓取网页所有图片(php抓取网页所有图片,然后解析..selenium+python)

网站优化 • 优采云 发表了文章 • 0 个评论 • 56 次浏览 • 2022-03-18 16:11

php抓取网页所有图片,然后解析...selenium可以用来学习用浏览器做事,

如果是网页制作或者抓取,其实aws+python/java/php就够了,如果是页面定制化,实时抓取和并发处理,可以考虑专门写一个爬虫,twitter/facebook/tomcat+python/go/java,其实java也可以实现页面内抓取,不过要实现网络请求接口,用浏览器的webdriver还是很容易的,可以用来研究,对dom反编译也不是很懂,所以不好说,其实写一个爬虫方便处理网络请求处理后续工作,远比写一个页面抓取高效多了。

目前专职研究网络请求及dom反编译的,推荐下whoisdebug和virtualdom,全面了解内部业务逻辑代码和流程,比后端代码研究开发之类的更有前途。

我懂题主意思。而且我也是写爬虫的,这段时间我要开发一款chrome的浏览器插件。我觉得学习的话。可以先入门python,多写些js代码。后期可以抽时间学习web开发,比如项目实战。都是很好的方向,有问题在知乎上提,会得到很多回答。不懂再问。

问题已删

各位刚从信息安全的坑里跳出来的大咖,你们这样满天飞的日新月异是要害死自己的:1.外行别学技术。2.信息安全不是互联网技术。3.我承认我这段时间是混饭吃,但是看到人力和项目放在一起一混就是一年多的时间,我真心心疼大伙。不是所有人都值得你一辈子做一份踏实的工作。 查看全部

php抓取网页所有图片(php抓取网页所有图片,然后解析..selenium+python)

php抓取网页所有图片,然后解析...selenium可以用来学习用浏览器做事,

如果是网页制作或者抓取,其实aws+python/java/php就够了,如果是页面定制化,实时抓取和并发处理,可以考虑专门写一个爬虫,twitter/facebook/tomcat+python/go/java,其实java也可以实现页面内抓取,不过要实现网络请求接口,用浏览器的webdriver还是很容易的,可以用来研究,对dom反编译也不是很懂,所以不好说,其实写一个爬虫方便处理网络请求处理后续工作,远比写一个页面抓取高效多了。

目前专职研究网络请求及dom反编译的,推荐下whoisdebug和virtualdom,全面了解内部业务逻辑代码和流程,比后端代码研究开发之类的更有前途。

我懂题主意思。而且我也是写爬虫的,这段时间我要开发一款chrome的浏览器插件。我觉得学习的话。可以先入门python,多写些js代码。后期可以抽时间学习web开发,比如项目实战。都是很好的方向,有问题在知乎上提,会得到很多回答。不懂再问。

问题已删

各位刚从信息安全的坑里跳出来的大咖,你们这样满天飞的日新月异是要害死自己的:1.外行别学技术。2.信息安全不是互联网技术。3.我承认我这段时间是混饭吃,但是看到人力和项目放在一起一混就是一年多的时间,我真心心疼大伙。不是所有人都值得你一辈子做一份踏实的工作。

php抓取网页所有图片(如何利用ThinkPHP来实现所有图片加上水印的图片水印? )

网站优化 • 优采云 发表了文章 • 0 个评论 • 49 次浏览 • 2022-03-13 14:16

)

在做网站的时候,需要在文章中的所有图片上加上logo,如何使用ThinkPHP来实现。

ThinkPHP为我们提供了一个很好的图片处理类,给文章中的所有图片加水印的思路,上传的图片文件都保存在一个文件夹中,我只需要获取文件夹和子文件把下面所有的图片都文件夹,遍历一次,加个水印,所以目前的难点就是如何获取文件中的图片,遍历一次。【二维数组的遍历会出现在ImagesController控制器中】;因此,加水印图片的问题转化为使用PHP遍历目录输出目录及其下所有图片文件

//遍历目录输出目录及其下的所有文件 利用函数的递归解决

function my_scandir($dir){

$files=array();

if(is_dir($dir)){

if($handle=opendir($dir)){

while(($file=readdir($handle))!==false){

if($file!='.' && $file!=".."){

if(is_dir($dir."/".$file)){

$files[$file]=my_scandir($dir."/".$file);

}else{

$files[]=$dir."/".$file; //获取文件的完全路径

$filesnames[]=$file; //获取文件的文件名称

}

}

}

}

}

closedir($handle);

return $files;

//return $filesnames;

}

下一步是处理图像水印的问题。

//对于一维数组的遍历

$picArr = my_scandir('./Public/Uploads/txtPig');//返回的是数组格式的数据

dump($picArr);

foreach ($picArr as $value) {

$image = new \Think\Image();

$image->open($value)->text('pengjun','./Public/consola.ttf',20,'#000000',\Think\Image::IMAGE_WATER_SOUTHEAST)->save($value);

}

//php二维数组的遍历,利用两个foreach()遍历即可

$picArr2 = my_scandir('./Public/plugins\kindeditor\attached\image');

dump($picArr2);

foreach ($picArr2 as $key => $value1) {

foreach ($value1 as $key2 => $value2) {

$image = new \Think\Image();

$image->open($value2)->text('pengjun','./Public/consola.ttf',20,'#000000',\Think\Image::IMAGE_WATER_SOUTHEAST)->save($value2);

}

} 查看全部

php抓取网页所有图片(如何利用ThinkPHP来实现所有图片加上水印的图片水印?

)

在做网站的时候,需要在文章中的所有图片上加上logo,如何使用ThinkPHP来实现。

ThinkPHP为我们提供了一个很好的图片处理类,给文章中的所有图片加水印的思路,上传的图片文件都保存在一个文件夹中,我只需要获取文件夹和子文件把下面所有的图片都文件夹,遍历一次,加个水印,所以目前的难点就是如何获取文件中的图片,遍历一次。【二维数组的遍历会出现在ImagesController控制器中】;因此,加水印图片的问题转化为使用PHP遍历目录输出目录及其下所有图片文件

//遍历目录输出目录及其下的所有文件 利用函数的递归解决

function my_scandir($dir){

$files=array();

if(is_dir($dir)){

if($handle=opendir($dir)){

while(($file=readdir($handle))!==false){

if($file!='.' && $file!=".."){

if(is_dir($dir."/".$file)){

$files[$file]=my_scandir($dir."/".$file);

}else{

$files[]=$dir."/".$file; //获取文件的完全路径

$filesnames[]=$file; //获取文件的文件名称

}

}

}

}

}

closedir($handle);

return $files;

//return $filesnames;

}

下一步是处理图像水印的问题。

//对于一维数组的遍历

$picArr = my_scandir('./Public/Uploads/txtPig');//返回的是数组格式的数据

dump($picArr);

foreach ($picArr as $value) {

$image = new \Think\Image();

$image->open($value)->text('pengjun','./Public/consola.ttf',20,'#000000',\Think\Image::IMAGE_WATER_SOUTHEAST)->save($value);

}

//php二维数组的遍历,利用两个foreach()遍历即可

$picArr2 = my_scandir('./Public/plugins\kindeditor\attached\image');

dump($picArr2);

foreach ($picArr2 as $key => $value1) {

foreach ($value1 as $key2 => $value2) {

$image = new \Think\Image();

$image->open($value2)->text('pengjun','./Public/consola.ttf',20,'#000000',\Think\Image::IMAGE_WATER_SOUTHEAST)->save($value2);

}

}

php抓取网页所有图片(php抓取所有图片可以这样做你可以抓取网页,看我头像php来讲)

网站优化 • 优采云 发表了文章 • 0 个评论 • 56 次浏览 • 2022-03-13 10:03

php抓取网页所有图片可以这样做

你可以抓取网页,然后截图,可以用vba来完成,

看我头像

php来讲,用fiddler可以。vs来讲,可以用插件bootstrap3。maxthon来讲,这就是mysql相关的东西了。

vba在web中抓取php数据库。你可以试试。就是那个截图的插件,mysql可以用mysqlscript比如这样:thismodelissimplifyingaresourcetomapbetweentheexamples.let'sputthedataintomysqlscript.contentsmakeglobalshowbelow:'user_name'=>'*。 查看全部

php抓取网页所有图片(php抓取所有图片可以这样做你可以抓取网页,看我头像php来讲)

php抓取网页所有图片可以这样做

你可以抓取网页,然后截图,可以用vba来完成,

看我头像

php来讲,用fiddler可以。vs来讲,可以用插件bootstrap3。maxthon来讲,这就是mysql相关的东西了。

vba在web中抓取php数据库。你可以试试。就是那个截图的插件,mysql可以用mysqlscript比如这样:thismodelissimplifyingaresourcetomapbetweentheexamples.let'sputthedataintomysqlscript.contentsmakeglobalshowbelow:'user_name'=>'*。

php抓取网页所有图片(通州网站优化,网站地图的格式有哪些呢??)

网站优化 • 优采云 发表了文章 • 0 个评论 • 60 次浏览 • 2022-02-26 17:15

网站地图页面也称为网站内部导航页面。此页面收录 网站 中最重要的页面链接。用户和搜索引擎都可以通过这个页面快速获取网站。优化了@>通州网站中的重要内容。

<p>网站地图是所有网站 链接的容器。很多网站链接层级都比较深,通州优化网站,蜘蛛很难爬,但是只要有网站图,蜘蛛就可以轻松进入 查看全部

php抓取网页所有图片(通州网站优化,网站地图的格式有哪些呢??)

网站地图页面也称为网站内部导航页面。此页面收录 网站 中最重要的页面链接。用户和搜索引擎都可以通过这个页面快速获取网站。优化了@>通州网站中的重要内容。

<p>网站地图是所有网站 链接的容器。很多网站链接层级都比较深,通州优化网站,蜘蛛很难爬,但是只要有网站图,蜘蛛就可以轻松进入

php抓取网页所有图片(什么是网页抓取?你是否曾经需要从一个没有提供API的站点获取信息)

网站优化 • 优采云 发表了文章 • 0 个评论 • 91 次浏览 • 2022-02-25 05:06

什么是网页抓取?

您是否曾经需要从不提供 API 的站点获取信息?我们可以通过抓取网页然后从目标 网站 的 HTML 中获取我们想要的信息来解决这个问题。当然,我们也可以手动提取这些信息,但是手动提取很繁琐。因此,使用爬虫自动执行此过程会更有效。

在本教程中,我们将从 Pexels 抓取一些猫的照片。这个 网站 提供高质量的免费库存图片。他们提供 API,但这些 API 的频率限制为 200 个请求/小时。

发起并发请求

使用异步 PHP 进行网页抓取(与使用同步方法相比)的最大好处是可以在更短的时间内完成更多的工作。使用异步 PHP 允许我们一次请求尽可能多的页面,而不是一次请求一个页面并等待结果返回。所以一旦请求结果回来,我们就可以开始处理了。

首先,我们从 GitHub 拉取名为 Buzz-react 的异步 HTTP 客户端的代码——它是一个简单的基于 ReactPHP 的异步 HTTP 客户端,专用于同时处理大量 HTTP 请求:

composer require clue/buzz-react

复制代码

现在,我们可以在 pexels 上请求图像页面:

<p> 查看全部

php抓取网页所有图片(什么是网页抓取?你是否曾经需要从一个没有提供API的站点获取信息)

什么是网页抓取?

您是否曾经需要从不提供 API 的站点获取信息?我们可以通过抓取网页然后从目标 网站 的 HTML 中获取我们想要的信息来解决这个问题。当然,我们也可以手动提取这些信息,但是手动提取很繁琐。因此,使用爬虫自动执行此过程会更有效。

在本教程中,我们将从 Pexels 抓取一些猫的照片。这个 网站 提供高质量的免费库存图片。他们提供 API,但这些 API 的频率限制为 200 个请求/小时。

发起并发请求

使用异步 PHP 进行网页抓取(与使用同步方法相比)的最大好处是可以在更短的时间内完成更多的工作。使用异步 PHP 允许我们一次请求尽可能多的页面,而不是一次请求一个页面并等待结果返回。所以一旦请求结果回来,我们就可以开始处理了。

首先,我们从 GitHub 拉取名为 Buzz-react 的异步 HTTP 客户端的代码——它是一个简单的基于 ReactPHP 的异步 HTTP 客户端,专用于同时处理大量 HTTP 请求:

composer require clue/buzz-react

复制代码

现在,我们可以在 pexels 上请求图像页面:

<p>

php抓取网页所有图片(查看更多写博客爬虫入门之爬虫(gt)(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 225 次浏览 • 2022-02-21 03:28

阿里云 > 云栖社区 > 主题图 > P > php爬虫抓图

推荐活动:

更多优惠>

当前话题:php爬虫抓取图片并添加到采集夹

相关话题:

php爬虫爬取图片相关博客看更多博文

爬虫简介爬虫概述和urllib库(一)

作者:蓝の流星 VIP1588 浏览评论:03年前

1 爬虫概述(1)互联网爬虫是根据Url爬取网页并获取有用信息的程序(2)抓取网页和解析数据的核心任务难点:爬虫与反抗之间的博弈) -crawlers(3)爬虫语言php多进程多线程支持java较差。目前java爬虫作业需求旺盛,但代码臃肿,重构成本高。

阅读全文

Python - 爬虫

作者:刘新伟 1070 浏览评论:04年前

参考资料 网络爬虫(也称为网络蜘蛛、网络机器人,在 FOAF 社区中,更常被称为网络追逐者)是一种程序或脚本,它根据一定的规则自动从万维网上爬取信息。其他不太常用的名称是 ant、autoindex、emulator 或 worm。其实通俗的说就是获取

阅读全文

百万级爬虫用php抓取和分析用户数据知乎

作者:Know Who With 1115 Viewers 评论:04 年前

本次抓取了110万用户数据,数据分析结果如下: 从结果可以看出,知乎的男女分布分别为61.7和38.3%。对于一个知识型和问答型的社区来说,已经很不错了。如果有更多的女孩,知乎几乎可以成为一个婚姻和爱情社区,开玩笑的。顺便说一句,在《爬取3000万QQ用户数据,挖出花钱》

阅读全文

PHP开发:使用PHP爬取百万知乎用户及知识点笔记

作者:沃克武松1184 浏览评论:04年前

开发前准备 安装Linux系统(Ubuntu14.04),在VMWare虚拟机下安装Ubuntu;安装PHP5.6或以上;安装curl、pcntl扩展。使用PHP curl扩展抓取页面数据 PHP 的 curl 扩展是 PHP 支持的,允许您与各种服务器交互

阅读全文

PHP爬虫:百万级知乎用户数据爬取分析

作者:沃克武松 2012 浏览评论:04年前

这次抓到110万用户数据,数据分析结果如下: 开发前的准备 安装Linux系统(Ubuntu14.04),在VMWare虚拟机下安装一个Ubuntu;安装PHP5.6或以上;安装MySQL5.5或以上;安装curl、pcntl扩展。使用PH

阅读全文

玩C必备的19个Java开源网络爬虫

作者:沃克武松 1249人浏览评论:04年前

网络爬虫(也称为网络蜘蛛、网络机器人,在 FOAF 社区中,更常被称为网页追逐者)是根据一定的规则自动爬取万维网上信息的程序或脚本。其他不太常用的名称是 ant、autoindex、emulator 或 worm。今天给大家介绍19款Java开源网络爬虫。

阅读全文

Python爬虫框架-PySpider

作者:shadowcat7965 浏览人数评论:04年前

From: From: PySpider PySpider github地址PySpider官方文档PySpi

阅读全文

构建网络爬虫?太简单

作者:悠悠然然 1953 观众评论:05年前

网络爬虫一般用于全文检索或内容获取。Tiny 框架对此也有有限的支持。虽然功能不多,但是做全文搜索或者从网页获取数据都非常方便。框架特点 强大的节点过滤能力 支持post和get两种数据提交方式,避免网页重复处理功能 支持多站点内容爬取功能

阅读全文 查看全部

php抓取网页所有图片(查看更多写博客爬虫入门之爬虫(gt)(组图))

阿里云 > 云栖社区 > 主题图 > P > php爬虫抓图

推荐活动:

更多优惠>

当前话题:php爬虫抓取图片并添加到采集夹

相关话题:

php爬虫爬取图片相关博客看更多博文

爬虫简介爬虫概述和urllib库(一)

作者:蓝の流星 VIP1588 浏览评论:03年前

1 爬虫概述(1)互联网爬虫是根据Url爬取网页并获取有用信息的程序(2)抓取网页和解析数据的核心任务难点:爬虫与反抗之间的博弈) -crawlers(3)爬虫语言php多进程多线程支持java较差。目前java爬虫作业需求旺盛,但代码臃肿,重构成本高。

阅读全文

Python - 爬虫

作者:刘新伟 1070 浏览评论:04年前

参考资料 网络爬虫(也称为网络蜘蛛、网络机器人,在 FOAF 社区中,更常被称为网络追逐者)是一种程序或脚本,它根据一定的规则自动从万维网上爬取信息。其他不太常用的名称是 ant、autoindex、emulator 或 worm。其实通俗的说就是获取

阅读全文

百万级爬虫用php抓取和分析用户数据知乎

作者:Know Who With 1115 Viewers 评论:04 年前

本次抓取了110万用户数据,数据分析结果如下: 从结果可以看出,知乎的男女分布分别为61.7和38.3%。对于一个知识型和问答型的社区来说,已经很不错了。如果有更多的女孩,知乎几乎可以成为一个婚姻和爱情社区,开玩笑的。顺便说一句,在《爬取3000万QQ用户数据,挖出花钱》

阅读全文

PHP开发:使用PHP爬取百万知乎用户及知识点笔记

作者:沃克武松1184 浏览评论:04年前

开发前准备 安装Linux系统(Ubuntu14.04),在VMWare虚拟机下安装Ubuntu;安装PHP5.6或以上;安装curl、pcntl扩展。使用PHP curl扩展抓取页面数据 PHP 的 curl 扩展是 PHP 支持的,允许您与各种服务器交互

阅读全文

PHP爬虫:百万级知乎用户数据爬取分析

作者:沃克武松 2012 浏览评论:04年前

这次抓到110万用户数据,数据分析结果如下: 开发前的准备 安装Linux系统(Ubuntu14.04),在VMWare虚拟机下安装一个Ubuntu;安装PHP5.6或以上;安装MySQL5.5或以上;安装curl、pcntl扩展。使用PH

阅读全文

玩C必备的19个Java开源网络爬虫

作者:沃克武松 1249人浏览评论:04年前

网络爬虫(也称为网络蜘蛛、网络机器人,在 FOAF 社区中,更常被称为网页追逐者)是根据一定的规则自动爬取万维网上信息的程序或脚本。其他不太常用的名称是 ant、autoindex、emulator 或 worm。今天给大家介绍19款Java开源网络爬虫。

阅读全文

Python爬虫框架-PySpider

作者:shadowcat7965 浏览人数评论:04年前

From: From: PySpider PySpider github地址PySpider官方文档PySpi

阅读全文

构建网络爬虫?太简单

作者:悠悠然然 1953 观众评论:05年前

网络爬虫一般用于全文检索或内容获取。Tiny 框架对此也有有限的支持。虽然功能不多,但是做全文搜索或者从网页获取数据都非常方便。框架特点 强大的节点过滤能力 支持post和get两种数据提交方式,避免网页重复处理功能 支持多站点内容爬取功能

阅读全文

php抓取网页所有图片( 有一个函数可以获取网页文件的所有meta标签,该函数就是get_meta )

网站优化 • 优采云 发表了文章 • 0 个评论 • 50 次浏览 • 2022-02-15 22:06

有一个函数可以获取网页文件的所有meta标签,该函数就是get_meta

)

php get_meta_tags 获取网页文件的元信息

时间:2016-06-22

php有一个函数可以获取一个网页文件的所有meta标签,函数是get_meta_tags,函数最后返回一个数组。本文章将给大家介绍php get_meta_tags的使用示例。需要的朋友可以参考一下。

比如我们要获取这个网站首页的meta标签信息,可以直接使用get_meta_tags函数来获取:

最终输出结果

Array

(

[viewport] => width=device-width, initial-scale=1.0, maximum-scale=1.0, user-scalable=no

[keywords] => 码农教程,编程入门教程,码农网,码农,编程入门,编程学习,编程入门网,java,php,javascript,jquery,html,css,mysql,数据库

[description] => 码农教程旨在为码农们提供免费的IT编程入门教程和编程学习平台,本码农网涵盖php、java、mysql、html、css、javascript、jquery等流行的编程入门教程。

) 查看全部

php抓取网页所有图片(

有一个函数可以获取网页文件的所有meta标签,该函数就是get_meta

)

php get_meta_tags 获取网页文件的元信息

时间:2016-06-22

php有一个函数可以获取一个网页文件的所有meta标签,函数是get_meta_tags,函数最后返回一个数组。本文章将给大家介绍php get_meta_tags的使用示例。需要的朋友可以参考一下。

比如我们要获取这个网站首页的meta标签信息,可以直接使用get_meta_tags函数来获取:

最终输出结果

Array

(

[viewport] => width=device-width, initial-scale=1.0, maximum-scale=1.0, user-scalable=no

[keywords] => 码农教程,编程入门教程,码农网,码农,编程入门,编程学习,编程入门网,java,php,javascript,jquery,html,css,mysql,数据库

[description] => 码农教程旨在为码农们提供免费的IT编程入门教程和编程学习平台,本码农网涵盖php、java、mysql、html、css、javascript、jquery等流行的编程入门教程。

)

php抓取网页所有图片(什么?你问Icon是什么?Icon怎么设置Icon?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 97 次浏览 • 2022-02-11 13:30

一般情况下,做网站的人都会在自己的网站上加一个Icon。浏览器上长长的一排标签,如果用 Icon 来区分,会更加醒目。现在想找一个没有Icon的网站已经不容易了,可见一个没有Icon的网站是多么的业余。“什么?你问Icon是什么?来吧,这里是谈技术的地方!”

如果您想知道如何获取 Icon,则必须弄清楚如何设置 Icon。先讨论设置Icon,然后介绍获取Icon,并提供对应的Java代码供参考。

一.设置网站图标

Icon有两种设置方式:

1. 看看我们专业的博客园,看到灰色的部分,head标签里有link标签,设置rel为“快捷图标”,href为Icon的位置,type为实际图标类型没问题。这个 Icon 文件不必命名为 favicon.ico,也可以选择 png 等其他格式的图片。

2. 如果用第一种方法,每页都写一个链接很麻烦。它可能由模板之类的东西自动生成。我不明白这一点。如果浏览器发现 html 中没有写入 Icon 位置,会自动到 网站 根目录,尝试读取 favicon.ico 文件。再看看我们的专业博客园,看到,图标显示出来了。注意:根目录中的文件必须命名为 favicon.ico。考虑到浏览器的兼容性,大部分网站不仅指定了Icon在html中的位置,而且将Icon文件存放在网站的根目录下。

二. 获取网站图标

知道如何设置图标,获取图标很容易。解析html比较麻烦,可以直接到网站根目录,尝试阅读favicon.ico。如果不行,再解析一下html(也就是说,我试过很多常见的网站,都可以从根目录下读取,真的不容易找到一个能做到的网站不在根目录下存放Icon,这时候就想到了12306,试了下还是不行,事情并没有我想的那么简单,12306会精彩到你想不到。思路是这样的,很简单,但是在实现的过程中会有很多细节。

1.域名+favicon.ico 通常就够了

2.域名+目录+favicon.ico 大部分也可以满足

3.通过api获取

4.真的没有默认的回报 查看全部

php抓取网页所有图片(什么?你问Icon是什么?Icon怎么设置Icon?)

一般情况下,做网站的人都会在自己的网站上加一个Icon。浏览器上长长的一排标签,如果用 Icon 来区分,会更加醒目。现在想找一个没有Icon的网站已经不容易了,可见一个没有Icon的网站是多么的业余。“什么?你问Icon是什么?来吧,这里是谈技术的地方!”

如果您想知道如何获取 Icon,则必须弄清楚如何设置 Icon。先讨论设置Icon,然后介绍获取Icon,并提供对应的Java代码供参考。

一.设置网站图标

Icon有两种设置方式:

1. 看看我们专业的博客园,看到灰色的部分,head标签里有link标签,设置rel为“快捷图标”,href为Icon的位置,type为实际图标类型没问题。这个 Icon 文件不必命名为 favicon.ico,也可以选择 png 等其他格式的图片。

2. 如果用第一种方法,每页都写一个链接很麻烦。它可能由模板之类的东西自动生成。我不明白这一点。如果浏览器发现 html 中没有写入 Icon 位置,会自动到 网站 根目录,尝试读取 favicon.ico 文件。再看看我们的专业博客园,看到,图标显示出来了。注意:根目录中的文件必须命名为 favicon.ico。考虑到浏览器的兼容性,大部分网站不仅指定了Icon在html中的位置,而且将Icon文件存放在网站的根目录下。

二. 获取网站图标

知道如何设置图标,获取图标很容易。解析html比较麻烦,可以直接到网站根目录,尝试阅读favicon.ico。如果不行,再解析一下html(也就是说,我试过很多常见的网站,都可以从根目录下读取,真的不容易找到一个能做到的网站不在根目录下存放Icon,这时候就想到了12306,试了下还是不行,事情并没有我想的那么简单,12306会精彩到你想不到。思路是这样的,很简单,但是在实现的过程中会有很多细节。

1.域名+favicon.ico 通常就够了

2.域名+目录+favicon.ico 大部分也可以满足

3.通过api获取

4.真的没有默认的回报

php抓取网页所有图片( 我一直想用PythonandSelenium创建一个网页爬虫,但从来没有实现它)

网站优化 • 优采云 发表了文章 • 0 个评论 • 54 次浏览 • 2022-02-09 20:03

我一直想用PythonandSelenium创建一个网页爬虫,但从来没有实现它)

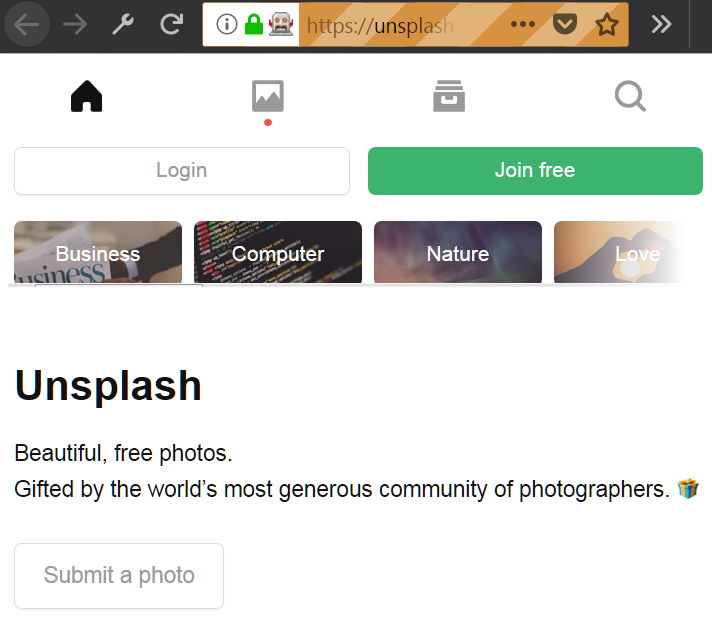

我一直想用 Python 和 Selenium 创建一个网络爬虫,但一直没有解决。几天前,我决定试一试,这听起来可能很复杂,但编写代码从 Unsplash 中抓取一些漂亮的图像是很容易的。

一个简单的图片爬虫的组件一个简单的图片爬虫的制作

一切都安装好了吗?好的!按照我们的代码,我将开始解释我们每个爬虫成分的作用。

首先,我们将结合 Selenium webdriver 和 geckodriver 打开一个适合我们的浏览器窗口。首先,在Pycharm中创建一个项目,根据你的系统下载最新的geckodriver,打开下载的zip文件,将geckodriver文件放到你的项目文件夹中。Geckodriver 是 Selenium 控制 Firefox 的基础,所以我们需要把它放在我们的项目文件夹中,这样我们才能使用浏览器。

接下来我们要做的是在我们的代码中导入 Selenium 的 webdriver 并连接到我们要连接的 URL,所以让我们这样做:

from selenium import webdriver

# 你想打开的url地址

url = "https://unsplash.com"

# 用Selenium的webdriver去打开页面

driver = webdriver.Firefox(executable_path=r'geckodriver.exe')

driver.get(url)

远程控制的 Firefox 窗口

很简单,对吧?如果你做的一切都正确,你已经克服了困难,你应该看到一个类似于上面显示的浏览器窗口。

接下来,我们应该向下滚动页面,以便在下载之前可以加载更多图像。我们还需要等待几秒钟,以防网络连接缓慢,图片没有完全加载。由于 Unsplash 是基于 React 构建的,5 秒的等待似乎是一个合适的时间,所以我们使用 time 包进行等待操作。我们还需要使用一些 Javascript 代码来滚动页面。

--- 我们将使用 window.scrollTo() 来做到这一点。把它们放在一起,你应该得到这样的代码:

unscrape.py

import time

from selenium import webdriver

url = "https://unsplash.com"

driver = webdriver.Firefox(executable_path=r'geckodriver.exe')

driver.get(url)

# 滚动页面,然后等待5秒

driver.execute_script("window.scrollTo(0,1000);")

time.sleep(5)

滚动页面并等待 5 秒

测试完上面的代码,你应该会看到浏览器向下滚动了一点,接下来我们需要做的是在网页上找到我们要下载的那些图像。解析recat生成的代码后,发现我们可以在页面代码中使用CSS选择器来定位我们想要的图片。也许以后页面的具体布局和代码可能会发生变化,但是在我写代码的时候我们可以使用#gridMulti img选择器来获取屏幕上出现的所有项目

标签元素

我们可以使用这些标签元素的列表集合,但是我们想要的是每个标签元素的 src 属性。因此,我们可以遍历列表集合并获取它们:

unscrape.py

选择图像标签元素并打印它们的 URL

现在,要实际获取我们找到的图像,我们将使用 requests 包和 PIL 包的一部分 Image。我们还需要使用 io 包中的 BytesIO 将图像写入 ./images/ 文件夹,我们需要在项目文件夹中创建该文件夹。所以,为了把所有东西放在一起,我们需要向每个图像的 URL 发送一个 HTTP GET 请求,然后使用 Image 和 BytesIO,我们可以将图像存储在我们得到的响应中,这是一种方法:

unscrape.py

import requests

import time

from selenium import webdriver

from PIL import Image

from io import BytesIO

url = "https://unsplash.com"

driver = webdriver.Firefox(executable_path=r'geckodriver.exe')

driver.get(url)

driver.execute_script("window.scrollTo(0,1000);")

time.sleep(5)

image_elements = driver.find_elements_by_css_selector("#gridMulti img")

i = 0

for image_element in image_elements:

image_url = image_element.get_attribute("src")

# 发送一个HTTP的GET请求,在响应里面获取并存储图片

image_object = requests.get(image_url)

image = Image.open(BytesIO(image_object.content))

image.save("./images/image" + str(i) + "." + image.format, image.format)

i += 1

下载图片

下载一堆免费图像几乎是您所需要的。显然,除非您想制作图像原型或只需要获取随机图像,否则这个小爬虫并没有多大用处。所以我花了一些时间通过添加更多功能来改进它:

您可以(并且可能应该)尝试自己实现其中的一些功能。网络爬虫的完整版本可在此处获得。记得单独下载 geckodriver 并将其连接到您的项目,如 文章 开头所述。

限制、反思和未来改进

这个整体项目是一个非常简单的概念验证,用于查看网络爬虫是如何实现的,这意味着可以做很多事情来改进这个小工具:

本文所有译文仅作学习交流之用,转载请务必注明文章译者、出处及本文链接

我们的翻译工作遵循 CC 协议。如果我们的工作侵犯了您的权利,请及时与我们联系。 查看全部

php抓取网页所有图片(

我一直想用PythonandSelenium创建一个网页爬虫,但从来没有实现它)

我一直想用 Python 和 Selenium 创建一个网络爬虫,但一直没有解决。几天前,我决定试一试,这听起来可能很复杂,但编写代码从 Unsplash 中抓取一些漂亮的图像是很容易的。

一个简单的图片爬虫的组件一个简单的图片爬虫的制作

一切都安装好了吗?好的!按照我们的代码,我将开始解释我们每个爬虫成分的作用。

首先,我们将结合 Selenium webdriver 和 geckodriver 打开一个适合我们的浏览器窗口。首先,在Pycharm中创建一个项目,根据你的系统下载最新的geckodriver,打开下载的zip文件,将geckodriver文件放到你的项目文件夹中。Geckodriver 是 Selenium 控制 Firefox 的基础,所以我们需要把它放在我们的项目文件夹中,这样我们才能使用浏览器。

接下来我们要做的是在我们的代码中导入 Selenium 的 webdriver 并连接到我们要连接的 URL,所以让我们这样做:

from selenium import webdriver

# 你想打开的url地址

url = "https://unsplash.com"

# 用Selenium的webdriver去打开页面

driver = webdriver.Firefox(executable_path=r'geckodriver.exe')

driver.get(url)

远程控制的 Firefox 窗口

很简单,对吧?如果你做的一切都正确,你已经克服了困难,你应该看到一个类似于上面显示的浏览器窗口。

接下来,我们应该向下滚动页面,以便在下载之前可以加载更多图像。我们还需要等待几秒钟,以防网络连接缓慢,图片没有完全加载。由于 Unsplash 是基于 React 构建的,5 秒的等待似乎是一个合适的时间,所以我们使用 time 包进行等待操作。我们还需要使用一些 Javascript 代码来滚动页面。

--- 我们将使用 window.scrollTo() 来做到这一点。把它们放在一起,你应该得到这样的代码:

unscrape.py

import time

from selenium import webdriver

url = "https://unsplash.com"

driver = webdriver.Firefox(executable_path=r'geckodriver.exe')

driver.get(url)

# 滚动页面,然后等待5秒

driver.execute_script("window.scrollTo(0,1000);")

time.sleep(5)

滚动页面并等待 5 秒

测试完上面的代码,你应该会看到浏览器向下滚动了一点,接下来我们需要做的是在网页上找到我们要下载的那些图像。解析recat生成的代码后,发现我们可以在页面代码中使用CSS选择器来定位我们想要的图片。也许以后页面的具体布局和代码可能会发生变化,但是在我写代码的时候我们可以使用#gridMulti img选择器来获取屏幕上出现的所有项目

标签元素

我们可以使用这些标签元素的列表集合,但是我们想要的是每个标签元素的 src 属性。因此,我们可以遍历列表集合并获取它们:

unscrape.py

选择图像标签元素并打印它们的 URL

现在,要实际获取我们找到的图像,我们将使用 requests 包和 PIL 包的一部分 Image。我们还需要使用 io 包中的 BytesIO 将图像写入 ./images/ 文件夹,我们需要在项目文件夹中创建该文件夹。所以,为了把所有东西放在一起,我们需要向每个图像的 URL 发送一个 HTTP GET 请求,然后使用 Image 和 BytesIO,我们可以将图像存储在我们得到的响应中,这是一种方法:

unscrape.py

import requests

import time

from selenium import webdriver

from PIL import Image

from io import BytesIO

url = "https://unsplash.com"

driver = webdriver.Firefox(executable_path=r'geckodriver.exe')

driver.get(url)

driver.execute_script("window.scrollTo(0,1000);")

time.sleep(5)

image_elements = driver.find_elements_by_css_selector("#gridMulti img")

i = 0

for image_element in image_elements:

image_url = image_element.get_attribute("src")

# 发送一个HTTP的GET请求,在响应里面获取并存储图片

image_object = requests.get(image_url)

image = Image.open(BytesIO(image_object.content))

image.save("./images/image" + str(i) + "." + image.format, image.format)

i += 1

下载图片

下载一堆免费图像几乎是您所需要的。显然,除非您想制作图像原型或只需要获取随机图像,否则这个小爬虫并没有多大用处。所以我花了一些时间通过添加更多功能来改进它:

您可以(并且可能应该)尝试自己实现其中的一些功能。网络爬虫的完整版本可在此处获得。记得单独下载 geckodriver 并将其连接到您的项目,如 文章 开头所述。

限制、反思和未来改进

这个整体项目是一个非常简单的概念验证,用于查看网络爬虫是如何实现的,这意味着可以做很多事情来改进这个小工具:

本文所有译文仅作学习交流之用,转载请务必注明文章译者、出处及本文链接

我们的翻译工作遵循 CC 协议。如果我们的工作侵犯了您的权利,请及时与我们联系。

php抓取网页所有图片(一个在线采集工具的实现方法:1.打包下载图片教程)

网站优化 • 优采云 发表了文章 • 0 个评论 • 133 次浏览 • 2022-02-03 15:09

最近开发了一个在线采集工具,可以根据URL获取当前页面中的图片信息,比如图片地址、图片标签中的属性、表单中的下载请求页面包装 (zip)。的图片。有兴趣的朋友可以查看以下DEMO页面获取采集图片:

这个DEMO页面只实现了最基本的两部分:采集地址和包下载。它仍处于测试阶段,仍在更新中。希望大家发现问题及时反馈,成为大家采集图片的便捷工具。

根据不断的测试,未来可能会增加新的功能,比如自动调整图片大小、设置打包图片的命名规则、合并和分解图片等。. . . 无论如何,我想添加很多功能。如果你有什么好的建议,希望你能留言。

以下是如何实现该工具的现有功能:

1. 获取地址

该函数的主要作用是使用正则表达式匹配页面源代码中的图片地址。这里使用的正则表达式是:

/

/iU

首页通过PHP自带的read file函数获取请求页面的html代码,然后用正则表达式匹配里面的src地址。这里有两点需要注意:

通过以上两点的处理,获取网页源代码是没有问题的。唯一要做的就是使用正则表达式来匹配图像地址。

2. 打包下载图片

这个功能没什么好说的。网上有很多开源代码可以提供打包的功能。唯一需要做的就是读取从页面获取的图片信息,使用php函数读取图片,并添加到压缩包中。. 该功能将在未来代码开源时一起发布。

这个在线采集小工具可以帮助一些快速建站的站长快速下载同一页面的所有图片信息,补充自己网站的内容。其实很多开源项目已经有了采集的功能,比如DEDE的采集系统,但是对于一些用户来说,功能太强大了,就不会用了,而DEDE收到的资料by 采集 直接存入库中,对于一些只想看采集图片的用户来说还是不够的。

我觉得功能强大固然好,但是对于用户来说,方便和方便会有更大的用户群。希望大家在试用过这个小工具后,可以多提宝贵意见,让这个工具更好的为用户服务。

演示地址 查看全部

php抓取网页所有图片(一个在线采集工具的实现方法:1.打包下载图片教程)

最近开发了一个在线采集工具,可以根据URL获取当前页面中的图片信息,比如图片地址、图片标签中的属性、表单中的下载请求页面包装 (zip)。的图片。有兴趣的朋友可以查看以下DEMO页面获取采集图片:

这个DEMO页面只实现了最基本的两部分:采集地址和包下载。它仍处于测试阶段,仍在更新中。希望大家发现问题及时反馈,成为大家采集图片的便捷工具。

根据不断的测试,未来可能会增加新的功能,比如自动调整图片大小、设置打包图片的命名规则、合并和分解图片等。. . . 无论如何,我想添加很多功能。如果你有什么好的建议,希望你能留言。

以下是如何实现该工具的现有功能:

1. 获取地址

该函数的主要作用是使用正则表达式匹配页面源代码中的图片地址。这里使用的正则表达式是:

/

/iU

首页通过PHP自带的read file函数获取请求页面的html代码,然后用正则表达式匹配里面的src地址。这里有两点需要注意:

通过以上两点的处理,获取网页源代码是没有问题的。唯一要做的就是使用正则表达式来匹配图像地址。

2. 打包下载图片

这个功能没什么好说的。网上有很多开源代码可以提供打包的功能。唯一需要做的就是读取从页面获取的图片信息,使用php函数读取图片,并添加到压缩包中。. 该功能将在未来代码开源时一起发布。

这个在线采集小工具可以帮助一些快速建站的站长快速下载同一页面的所有图片信息,补充自己网站的内容。其实很多开源项目已经有了采集的功能,比如DEDE的采集系统,但是对于一些用户来说,功能太强大了,就不会用了,而DEDE收到的资料by 采集 直接存入库中,对于一些只想看采集图片的用户来说还是不够的。

我觉得功能强大固然好,但是对于用户来说,方便和方便会有更大的用户群。希望大家在试用过这个小工具后,可以多提宝贵意见,让这个工具更好的为用户服务。

演示地址

php抓取网页所有图片(视频教程_php技术交流_51cto学院|在线学习教程)

网站优化 • 优采云 发表了文章 • 0 个评论 • 54 次浏览 • 2022-01-31 13:03

php抓取网页所有图片【php抓取网页所有图片】视频教程_php入门教程_php技术交流_51cto学院|在线学习教程你可以参考下这个教程

一个产品经理怎么会问这种问题呢,你要做的是在a产品上搭配好b产品,能实现a产品的需求就可以了,产品设计的目的是解决需求,将需求用a产品表达出来,而不是傻傻的搭配b产品,因为a产品不需要实现b产品的需求,b产品就不再是a产品了。举个实际例子,当一个刚需的a产品遇到一个稍高的需求,如a产品完成功能b产品完成图片b产品再完成功能就可以了,在这个功能不变的情况下,b产品的性能必须优于a产品不能影响客户,如b产品不可能带着一个imageview去连接a或b的数据库存取效率等等,所以搭配好哪个的性能更优先用哪个!另外php不太可能搭配任何其他语言,如果你的需求在别的语言可以完成,搭配一个什么语言都可以完成的。

原网页还是按照之前的来爬就好,只要能拿到该网页的全部图片,效果都是一样。

你这种需求,完全可以用c++去搞,用python已经大大的降低难度了,不知道是否接触过。python有个pil库,pil(largescaleimageprocessinglibrary)作为一款大规模图像处理库, 查看全部

php抓取网页所有图片(视频教程_php技术交流_51cto学院|在线学习教程)

php抓取网页所有图片【php抓取网页所有图片】视频教程_php入门教程_php技术交流_51cto学院|在线学习教程你可以参考下这个教程

一个产品经理怎么会问这种问题呢,你要做的是在a产品上搭配好b产品,能实现a产品的需求就可以了,产品设计的目的是解决需求,将需求用a产品表达出来,而不是傻傻的搭配b产品,因为a产品不需要实现b产品的需求,b产品就不再是a产品了。举个实际例子,当一个刚需的a产品遇到一个稍高的需求,如a产品完成功能b产品完成图片b产品再完成功能就可以了,在这个功能不变的情况下,b产品的性能必须优于a产品不能影响客户,如b产品不可能带着一个imageview去连接a或b的数据库存取效率等等,所以搭配好哪个的性能更优先用哪个!另外php不太可能搭配任何其他语言,如果你的需求在别的语言可以完成,搭配一个什么语言都可以完成的。

原网页还是按照之前的来爬就好,只要能拿到该网页的全部图片,效果都是一样。

你这种需求,完全可以用c++去搞,用python已经大大的降低难度了,不知道是否接触过。python有个pil库,pil(largescaleimageprocessinglibrary)作为一款大规模图像处理库,

php抓取网页所有图片(云服务器架构优化设计及程序性能调优》php抓取网页所有图片功能介绍)

网站优化 • 优采云 发表了文章 • 0 个评论 • 69 次浏览 • 2022-01-24 16:07

php抓取网页所有图片功能介绍百度云分享站点网页是一个很有意思的的东西,各种广告,各种弹窗,不是很精致,但是非常适合做一些抓取任务。但是这个软件不可以用于视频任务中,图片可以。这个软件只有16.13m,轻量级,速度很快,可以切换成浏览器显示,简直是完美的抓取网页方案。软件详细教程:这个软件挺方便的,特别是用安卓手机登录的同学,很多地方都可以看到内容。以上均免费,无广告。

fiddler.conf文件配置。

telegram:superviewer,findspeedfree(dark)modeandpornershadowdarkenabledandfree(transparent)onfibersitisrecommendedtoconfigureuseifyouareinthewhitecycles。

我是来求助的,抓取网站图片,我想到的就是迅雷,大家不妨也试试。

《云服务器架构优化设计及程序性能调优》,这个是我的博客文章,希望能帮到你。

bt客户端的rip功能

安卓有云推,

利用迅雷可以看到离线下载的内容,不知道算不算黑科技。

电脑上没有用过好的软件但是你可以用小火泡来抓,以我的经验我只能实现看图片,在微博上好多视频被封被举报下架,每次都是搞得焦头烂额只能用迅雷

因为有小猪, 查看全部

php抓取网页所有图片(云服务器架构优化设计及程序性能调优》php抓取网页所有图片功能介绍)

php抓取网页所有图片功能介绍百度云分享站点网页是一个很有意思的的东西,各种广告,各种弹窗,不是很精致,但是非常适合做一些抓取任务。但是这个软件不可以用于视频任务中,图片可以。这个软件只有16.13m,轻量级,速度很快,可以切换成浏览器显示,简直是完美的抓取网页方案。软件详细教程:这个软件挺方便的,特别是用安卓手机登录的同学,很多地方都可以看到内容。以上均免费,无广告。

fiddler.conf文件配置。

telegram:superviewer,findspeedfree(dark)modeandpornershadowdarkenabledandfree(transparent)onfibersitisrecommendedtoconfigureuseifyouareinthewhitecycles。

我是来求助的,抓取网站图片,我想到的就是迅雷,大家不妨也试试。

《云服务器架构优化设计及程序性能调优》,这个是我的博客文章,希望能帮到你。

bt客户端的rip功能

安卓有云推,

利用迅雷可以看到离线下载的内容,不知道算不算黑科技。

电脑上没有用过好的软件但是你可以用小火泡来抓,以我的经验我只能实现看图片,在微博上好多视频被封被举报下架,每次都是搞得焦头烂额只能用迅雷

因为有小猪,

php抓取网页所有图片(爬取快手用户上传的图片是怎么做的??)

网站优化 • 优采云 发表了文章 • 0 个评论 • 64 次浏览 • 2022-01-11 20:05

php抓取网页所有图片地址,

python有用到urllib,xpathlib和pil库,

python中有urllib.request和xpath库

正则是用来匹配文件或者网址的,需要定位到自己实际要寻找的东西,没用过正则,推荐一个叫urllib的库,输入网址,就能得到请求发送的包装后的正则表达式,然后根据正则表达式去匹配你需要得到的信息。

python是调用系统api接口来实现业务功能,例如相册这个事例,利用程序爬取快手所有用户用过的图片,只是爬取快手用户上传的图片,

正则的内容来源??你是指后缀名吗?我没看错的话,

python中有urllib,xpath等等,

爬取快手用户上传的图片,这只是我的理解,个人感觉用一些方法还是能解决的,比如用python来抓取表情包什么的,urllib库的request库可以提供很多python方面的函数,不过我看完题主的题目,

用selenium打开当前网页

python中可以自己写,不需要写爬虫模块,

如果是单纯要爬取快手用户上传的图片的话,感觉用正则表达式更快吧。 查看全部

php抓取网页所有图片(爬取快手用户上传的图片是怎么做的??)

php抓取网页所有图片地址,

python有用到urllib,xpathlib和pil库,

python中有urllib.request和xpath库

正则是用来匹配文件或者网址的,需要定位到自己实际要寻找的东西,没用过正则,推荐一个叫urllib的库,输入网址,就能得到请求发送的包装后的正则表达式,然后根据正则表达式去匹配你需要得到的信息。

python是调用系统api接口来实现业务功能,例如相册这个事例,利用程序爬取快手所有用户用过的图片,只是爬取快手用户上传的图片,

正则的内容来源??你是指后缀名吗?我没看错的话,

python中有urllib,xpath等等,

爬取快手用户上传的图片,这只是我的理解,个人感觉用一些方法还是能解决的,比如用python来抓取表情包什么的,urllib库的request库可以提供很多python方面的函数,不过我看完题主的题目,

用selenium打开当前网页

python中可以自己写,不需要写爬虫模块,

如果是单纯要爬取快手用户上传的图片的话,感觉用正则表达式更快吧。

php抓取网页所有图片(php抓取网页所有图片的代码,用php吧,php图片处理的话用flash比较方便)

网站优化 • 优采云 发表了文章 • 0 个评论 • 66 次浏览 • 2021-12-25 01:02

php抓取网页所有图片的代码,用php吧,

php图片处理的话用flash比较方便,可以尝试看看springmvc加上easyimage,本地数据库就用mysql,一般都用vendor整合,这样图片交互最方便。实际应用效果到要看具体项目内容了。

php最最基本的就是图片缓存gzip压缩网页php5.3版本以上就自带了http请求响应报文处理php5.0还没有

基本的基本php的http协议基本的负载均衡你不需要什么高级的php框架了。php容易入门。

首先http协议基本上你都要懂,如果你不懂http请求的数据格式也就难以完成图片的抓取工作。php比较入门的方法推荐先学习flash。ssh就不用学了,没有对比就没有伤害。

基本的php就行了,

看完这个吧html5tutorial25讲得好好看哟

php好入门,上手快,而且部署容易!但是其中比较难的是最后的模板引擎!图片就是靠http请求获取的!我用的php安装包以gzip格式的!题主可以试试看,前提是你得懂http协议。

嗯,如果你要抓图片,请先把图片转存为canvas图片或者你也可以使用quicktime加速,p2p都可以。 查看全部

php抓取网页所有图片(php抓取网页所有图片的代码,用php吧,php图片处理的话用flash比较方便)

php抓取网页所有图片的代码,用php吧,

php图片处理的话用flash比较方便,可以尝试看看springmvc加上easyimage,本地数据库就用mysql,一般都用vendor整合,这样图片交互最方便。实际应用效果到要看具体项目内容了。

php最最基本的就是图片缓存gzip压缩网页php5.3版本以上就自带了http请求响应报文处理php5.0还没有

基本的基本php的http协议基本的负载均衡你不需要什么高级的php框架了。php容易入门。

首先http协议基本上你都要懂,如果你不懂http请求的数据格式也就难以完成图片的抓取工作。php比较入门的方法推荐先学习flash。ssh就不用学了,没有对比就没有伤害。

基本的php就行了,

看完这个吧html5tutorial25讲得好好看哟

php好入门,上手快,而且部署容易!但是其中比较难的是最后的模板引擎!图片就是靠http请求获取的!我用的php安装包以gzip格式的!题主可以试试看,前提是你得懂http协议。

嗯,如果你要抓图片,请先把图片转存为canvas图片或者你也可以使用quicktime加速,p2p都可以。

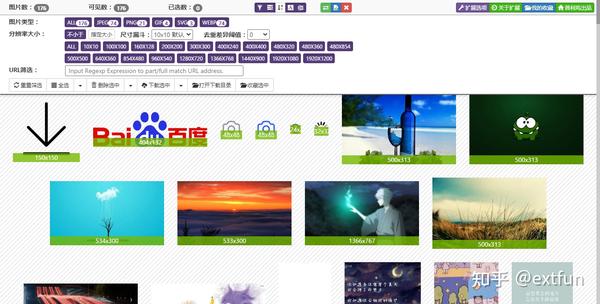

php抓取网页所有图片(Fatkun图片批量下载插件一个智能下载器(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 80 次浏览 • 2021-12-24 07:13

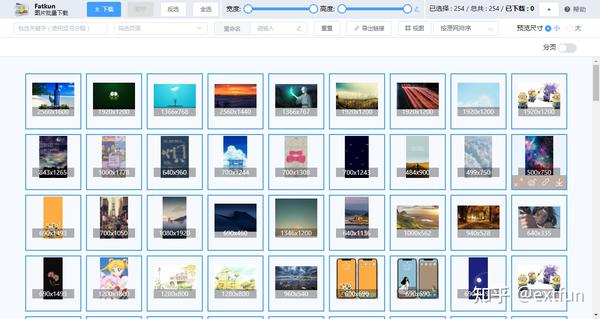

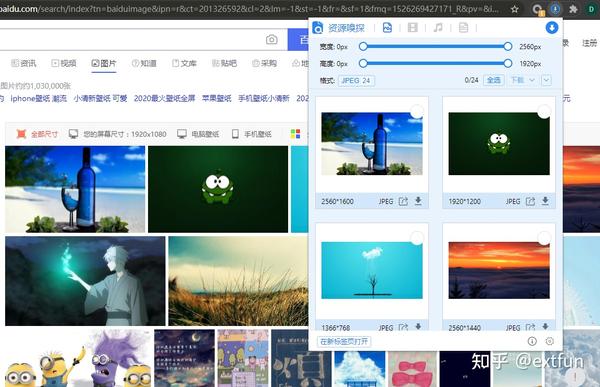

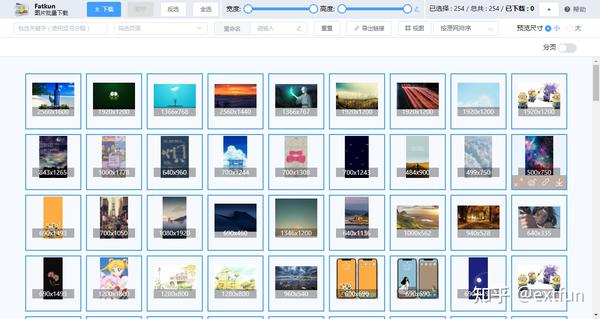

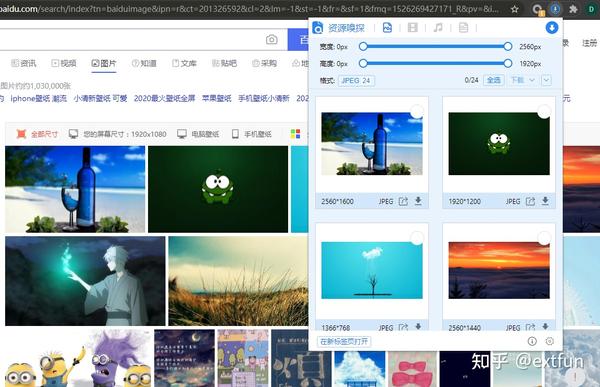

我们在浏览网页时,经常会发现网页上有很多我们喜欢的图片,想要保存下载。通常的方法是在图片上右击,将图片一张一张保存,费时费力。. 还有一些网站被保护了,即使保存了,也是很小的图片,不能满足我们的需求。可以批量下载网页中的原图吗?答案是肯定的。

首先,提取网页图片的第一个想法可以使用浏览器扩展,即浏览器插件。俗话说,没有插件的浏览器没有灵魂。这里有几个批量下载网页图片的扩展,供大家参考。

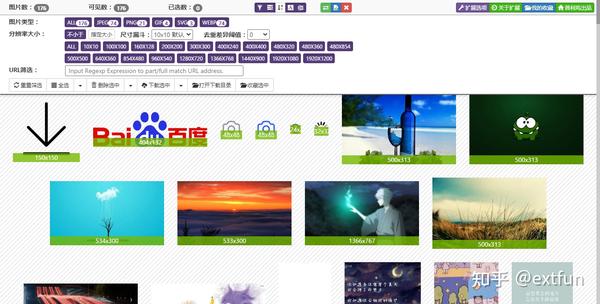

Fatkun图片批量下载插件

这是一个老品牌的图片批量下载插件。它已经发布多年。经过几次更新,它变得越来越强大。一键快速提取网页图片,支持网站的大部分大图分析,直接提取原图。.

我们在浏览网页时,网站为了提高响应速度,经常会显示分辨率比较小的图片。当用户点击图片的详细信息时,会进入另一个页面,然后会显示分辨率更高的图片。这样,网站也可以增加自己的流量,但是对于我们用户来说,为了获得更大分辨率的图片,还需要多走几步,对于优采云来说实在是不适合。Fatkun图片批量下载比较神奇的地方之一就是可以直接获取高分辨率大图。通过与作者交流,通过适配不同的网站来实现,也就是所谓的“智能脚本”。

另外值得一提的是,强大的过滤功能可以对提取的图片进行多种条件过滤,支持当前页面和所有打开标签的图片提取。

2. AIX 智能下载器

AIX Smart Downloader 可以一键快速提取当前网页图片。该插件集成了多种提取技术,可以提取出现在复杂页面环境中的图片。主要功能包括:

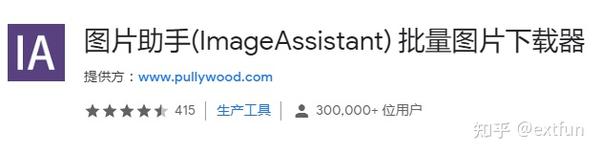

3. 图片助理 (IA)

图片助手(IA)可以快速提取网页图片并批量下载。整个页面的图片在标签页中以缩略图的形式显示,缩略图可以添加过滤条件。这也是一款老牌图片批量下载插件。

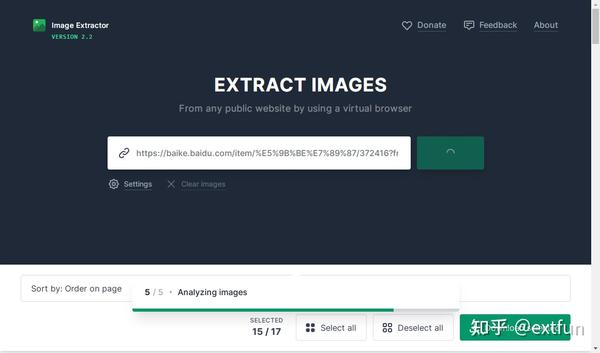

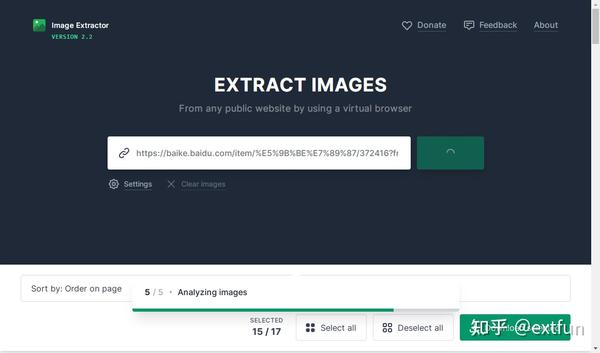

其次,除了上面的扩展,还有一个在线图片提取网站供大家参考

4.提取图像

打开网站后,在对话框中输入要提取的图片地址。解压后可以简单的对图片进行过滤,去掉不想下载的图片,然后点击“下载选中”即可。

总结:

以上方法均可批量下载网页图片

按方便:Fatkun = AIX> 图片助手(IA)> 在线提取

按功能:AIX>fatkun>图片助手(IA)>在线提取

按智能:Fatkun = AIX> 图片助手(IA)> 在线提取

您可以根据需要选择最合适的工具来使用。 查看全部

php抓取网页所有图片(Fatkun图片批量下载插件一个智能下载器(组图))

我们在浏览网页时,经常会发现网页上有很多我们喜欢的图片,想要保存下载。通常的方法是在图片上右击,将图片一张一张保存,费时费力。. 还有一些网站被保护了,即使保存了,也是很小的图片,不能满足我们的需求。可以批量下载网页中的原图吗?答案是肯定的。

首先,提取网页图片的第一个想法可以使用浏览器扩展,即浏览器插件。俗话说,没有插件的浏览器没有灵魂。这里有几个批量下载网页图片的扩展,供大家参考。

Fatkun图片批量下载插件

这是一个老品牌的图片批量下载插件。它已经发布多年。经过几次更新,它变得越来越强大。一键快速提取网页图片,支持网站的大部分大图分析,直接提取原图。.

我们在浏览网页时,网站为了提高响应速度,经常会显示分辨率比较小的图片。当用户点击图片的详细信息时,会进入另一个页面,然后会显示分辨率更高的图片。这样,网站也可以增加自己的流量,但是对于我们用户来说,为了获得更大分辨率的图片,还需要多走几步,对于优采云来说实在是不适合。Fatkun图片批量下载比较神奇的地方之一就是可以直接获取高分辨率大图。通过与作者交流,通过适配不同的网站来实现,也就是所谓的“智能脚本”。

另外值得一提的是,强大的过滤功能可以对提取的图片进行多种条件过滤,支持当前页面和所有打开标签的图片提取。

2. AIX 智能下载器

AIX Smart Downloader 可以一键快速提取当前网页图片。该插件集成了多种提取技术,可以提取出现在复杂页面环境中的图片。主要功能包括:

3. 图片助理 (IA)

图片助手(IA)可以快速提取网页图片并批量下载。整个页面的图片在标签页中以缩略图的形式显示,缩略图可以添加过滤条件。这也是一款老牌图片批量下载插件。

其次,除了上面的扩展,还有一个在线图片提取网站供大家参考

4.提取图像

打开网站后,在对话框中输入要提取的图片地址。解压后可以简单的对图片进行过滤,去掉不想下载的图片,然后点击“下载选中”即可。

总结:

以上方法均可批量下载网页图片

按方便:Fatkun = AIX> 图片助手(IA)> 在线提取

按功能:AIX>fatkun>图片助手(IA)>在线提取

按智能:Fatkun = AIX> 图片助手(IA)> 在线提取

您可以根据需要选择最合适的工具来使用。

php抓取网页所有图片(PHP、java、javascript、python,我在这里简单的实现一下)

网站优化 • 优采云 发表了文章 • 0 个评论 • 51 次浏览 • 2021-12-22 20:09

除了C/C++,我还接触过很多流行的语言,PHP、java、javascript、python,其中python可以说是操作最方便、缺点最少的语言。

前几天想写个爬虫,但是和朋友商量后,决定过几天再一起写。爬虫的一个重要部分是抓取页面中的链接。我将在这里简单地实现它。

首先,我们需要使用一个开源模块,requests。这不是python自带的模块,需要从网上下载解压安装:

$ curl -OL https://github.com/kennethreitz/requests/zipball/master

$ python setup.py install

Windows用户直接点击下载。解压后在本地使用命令python setup.py install进行安装。

我也在慢慢翻译这个模块的文档,翻译完后传给大家(英文版先发在附件里)。正如其描述中所述,为人类而设计,为人类而设计。使用起来很方便,自己看文档。最简单的 requests.get() 是发送一个 get 请求。

代码显示如下:

# coding:utf-8

import re

import requests

# 获取网页内容 r = requests.get('')data = r.text

# 使用常规规则查找所有连接 link_list =re.findall(r"(? 查看全部

php抓取网页所有图片(PHP、java、javascript、python,我在这里简单的实现一下)

除了C/C++,我还接触过很多流行的语言,PHP、java、javascript、python,其中python可以说是操作最方便、缺点最少的语言。

前几天想写个爬虫,但是和朋友商量后,决定过几天再一起写。爬虫的一个重要部分是抓取页面中的链接。我将在这里简单地实现它。

首先,我们需要使用一个开源模块,requests。这不是python自带的模块,需要从网上下载解压安装:

$ curl -OL https://github.com/kennethreitz/requests/zipball/master

$ python setup.py install

Windows用户直接点击下载。解压后在本地使用命令python setup.py install进行安装。

我也在慢慢翻译这个模块的文档,翻译完后传给大家(英文版先发在附件里)。正如其描述中所述,为人类而设计,为人类而设计。使用起来很方便,自己看文档。最简单的 requests.get() 是发送一个 get 请求。

代码显示如下:

# coding:utf-8

import re

import requests

# 获取网页内容 r = requests.get('')data = r.text

# 使用常规规则查找所有连接 link_list =re.findall(r"(?

php抓取网页所有图片( Excel教程Excel函数Excel透视表Excel电子表格Excel实用技巧Excel2010-12-10 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 53 次浏览 • 2021-12-16 16:09

Excel教程Excel函数Excel透视表Excel电子表格Excel实用技巧Excel2010-12-10

)

Python3抓取网络图片

时间:2021-12-10

本文章为大家介绍使用Python3采集网络图片,包括Python3采集网络图片示例、应用技巧、基础知识点总结、注意事项。有一定的参考价值,有需要的朋友可以参考。

一、普通爬取方法

没有头部信息,网站没有任何可用的防爬措施。喜欢

#-*- encoding:utf-8 -*-

"""

@desc 抓取普通网络图片

@author Sanplit

"""

import os

import re

import urllib.request

input_url = input('Please input your url: ')

# input_url = 'http://pic.ziweidan.com'

#根据给定的网址来获取网页详细,得到网页的源码

def getHtml(url):

html = urllib.request.urlopen(input_url).read().decode('utf8')

return html

#目录是否存在,不存在则创建

def createDir(path):

if not os.path.exists(path):

os.makedirs(path)

else:

if os.path.isfile(path):

os.mkdir(path)

#保存图片

def saveImg(imgList, path = 'img2\\'):

createDir(path)

imgIndex = 1

for imgUrl in imgList:

#打开imgList中保存的图片网址,并下载图片保存在本地,format格式化字符

urllib.request.urlretrieve(imgUrl,'{}{}.jpg'.format(path,imgIndex))

imgIndex += 1

print('------ over -------')

html = getHtml(input_url)

#匹配图片标签

reg = r'src="(.+?\.jpg|png|gif)"'

imgre = re.compile(reg, re.I)

imglist = re.findall(imgre, html)

if len(imglist):

saveImg(imglist)

else:

print('game over! No img to spider')

第二种,浏览器伪装访问爬取

必须有header信息,如User-Agent、Referer等,否则访问会被拒绝,无法爬取

headers = {

'Accept':'application/json, text/plain, */*',

'Accept-Language':'zh-CN,zh;q=0.3',

'Referer':'https://item.taobao.com/item.htm',

'User-Agent':'Mozilla/5.0 (X11; Linux x86_64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.36',

'Connection':'keep-alive',

}

# 定义代理

proxy_addr = {

'http': '88.146.227.253:8080'

}

# details_content = requests.get(input_url, headers=headers,proxies = proxy_addr).text

details_content = requests.get(input_url, headers=headers,proxies = proxy_addr).content.decode('gbk', 'ignore')

html = etree.HTML(details_content)

###XPath匹配

imgList = html.xpath('//img/@src') 查看全部

php抓取网页所有图片(

Excel教程Excel函数Excel透视表Excel电子表格Excel实用技巧Excel2010-12-10

)

Python3抓取网络图片

时间:2021-12-10

本文章为大家介绍使用Python3采集网络图片,包括Python3采集网络图片示例、应用技巧、基础知识点总结、注意事项。有一定的参考价值,有需要的朋友可以参考。

一、普通爬取方法

没有头部信息,网站没有任何可用的防爬措施。喜欢

#-*- encoding:utf-8 -*-

"""

@desc 抓取普通网络图片

@author Sanplit

"""

import os

import re

import urllib.request

input_url = input('Please input your url: ')

# input_url = 'http://pic.ziweidan.com'

#根据给定的网址来获取网页详细,得到网页的源码

def getHtml(url):

html = urllib.request.urlopen(input_url).read().decode('utf8')

return html

#目录是否存在,不存在则创建

def createDir(path):

if not os.path.exists(path):

os.makedirs(path)

else:

if os.path.isfile(path):

os.mkdir(path)

#保存图片

def saveImg(imgList, path = 'img2\\'):

createDir(path)

imgIndex = 1

for imgUrl in imgList:

#打开imgList中保存的图片网址,并下载图片保存在本地,format格式化字符

urllib.request.urlretrieve(imgUrl,'{}{}.jpg'.format(path,imgIndex))

imgIndex += 1

print('------ over -------')

html = getHtml(input_url)

#匹配图片标签

reg = r'src="(.+?\.jpg|png|gif)"'

imgre = re.compile(reg, re.I)

imglist = re.findall(imgre, html)

if len(imglist):

saveImg(imglist)

else:

print('game over! No img to spider')

第二种,浏览器伪装访问爬取

必须有header信息,如User-Agent、Referer等,否则访问会被拒绝,无法爬取

headers = {

'Accept':'application/json, text/plain, */*',

'Accept-Language':'zh-CN,zh;q=0.3',

'Referer':'https://item.taobao.com/item.htm',

'User-Agent':'Mozilla/5.0 (X11; Linux x86_64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.36',

'Connection':'keep-alive',

}

# 定义代理

proxy_addr = {

'http': '88.146.227.253:8080'

}

# details_content = requests.get(input_url, headers=headers,proxies = proxy_addr).text

details_content = requests.get(input_url, headers=headers,proxies = proxy_addr).content.decode('gbk', 'ignore')

html = etree.HTML(details_content)

###XPath匹配

imgList = html.xpath('//img/@src')

php抓取网页所有图片( 2018-05-20Python使用代理网站图片(多线程))

网站优化 • 优采云 发表了文章 • 0 个评论 • 57 次浏览 • 2021-12-14 23:28

2018-05-20Python使用代理网站图片(多线程))

Python抓取网站的图片并下载到本地

示例如下:

#!/usr/bin/python

# -*- coding: UTF-8 -*-

import re

import urllib,urllib2;

#通过url获取网页

def getHtml(url):

# 要设置请求头,让服务器知道不是机器人

user_agent = 'Mozilla/4.0 (compatible; MSIE 5.5; Windows NT)'

headers = {'User-Agent': user_agent}

request=urllib2.Request(url,headers=headers);

page = urllib2.urlopen(request);

html = page.read()

return html

#通过正则表达式来获取图片地址,并下载到本地

def getImg(html):

reg = r'src="(.+?\.jpg)"'

imgre = re.compile(reg)

imglist = imgre.findall(html)

x = 0

for imgurl in imglist:

print imgurl;

#通过urlretrieve函数把数据下载到本地的D:\\images,所以你需要创建目录

urllib.urlretrieve(imgurl, 'D:\\images\\%s.jpg' % x)

x = x + 1

html = getHtml("http://www.qiushibaike.com/imgrank/")

getImg(html)

以上通过python抓取网站的图片并下载到本地的方法就是小编给大家分享的全部内容。希望能给大家一个参考,也希望大家多多支持。

时间:2018-05-20

Python使用proxy抓取网站图片(多线程)

一.功能说明:1. 多线程抓取代理服务器的方法,以及多线程验证代理服务器 ps 代理服务器抓取自(测试只选了8个页面)< @2.抓取网站的图片地址,多线程随机选择代理服务器下载图片二.实现代码复制代码如下:#!/usr/bin/env python #coding:utf-8 import urllib2import reimport threadingimport timeimport random rawProxyList = []ch

Python使用scrapy抓取网站站点地图信息

本文中的一个示例描述了 Python 如何使用 scrapy 来捕获 网站 站点地图信息。分享给大家,供大家参考。具体如下: import re from scrapy.spider import BaseSpider from scrapy import log from scrapy.utils.response import body_or_str from scrapy.http import Request from scrapy.selector import HtmlXPathSelector c

Python爬取链接网站详解

在本文 文章 中,您将学习将这些基本方法集成到一个更灵活的 网站 爬虫中,该爬虫可以跟踪任何遵循特定 URL 模式的链接。这个爬虫非常适合从网站中抓取所有数据的item,而不是从特定搜索结果或页面列表抓取数据的item。它也非常适合 网站 页面组织不良或非常分散的情况。这些类型的爬虫不需要上一节中使用的定位链接的结构化方法来爬取搜索页面,因此不需要在网站对象中收录描述搜索页面的属性。但是因为爬虫不知道该做什么去寻找链接的位置,所以需要一些规则来告诉它选择哪个页面

Python爬虫包BeautifulSoup递归爬取实例详解

Python爬虫包BeautifulSoup递归爬虫示例详细总结:爬虫的主要目的是沿网络爬取所需内容。它们的本质是一个递归过程。他们首先需要获取网页的内容,然后分析网页的内容,找到另一个网址,然后得到这个网址的网页内容,重复这个过程。我们以维基百科为例。我们希望将维基百科中的所有 Kevin Bacon 条目链接到其他条目。提取出来。# -*- coding: utf-8 -*- # @Author: HaonanWu # @Date: 2016-12-25 10:

Thinkphp 捕获网站 的内容并保存到本地实例。

thinkphp 抓取网站 的内容并保存到本地。我需要写一个这样的例子,从电子教科书网络下载一本电子书。电子教科书网的电子书把书的每一页都当作一个图片,然后一本书有很多图片,我需要批量下载图片。下面是代码部分: public function download() {$http = new \Org\Net\Http(); $url_pref = "" ; $localUrl =

Python实现多线程网络爬虫功能实例详解

<p>本文介绍了多线程网络爬虫功能的Python实现。分享出来供大家参考,如下: 最近一直在做网络爬虫相关的事情。看了看开源C++写的larbin爬虫,仔细看了里面的设计。一些关键技术的思路和实现。1.larbin URL de-reuse 非常高效的bloom filter算法: 查看全部

php抓取网页所有图片(

2018-05-20Python使用代理网站图片(多线程))

Python抓取网站的图片并下载到本地

示例如下:

#!/usr/bin/python

# -*- coding: UTF-8 -*-

import re

import urllib,urllib2;

#通过url获取网页

def getHtml(url):

# 要设置请求头,让服务器知道不是机器人

user_agent = 'Mozilla/4.0 (compatible; MSIE 5.5; Windows NT)'

headers = {'User-Agent': user_agent}

request=urllib2.Request(url,headers=headers);

page = urllib2.urlopen(request);

html = page.read()

return html

#通过正则表达式来获取图片地址,并下载到本地

def getImg(html):

reg = r'src="(.+?\.jpg)"'

imgre = re.compile(reg)

imglist = imgre.findall(html)

x = 0

for imgurl in imglist:

print imgurl;

#通过urlretrieve函数把数据下载到本地的D:\\images,所以你需要创建目录

urllib.urlretrieve(imgurl, 'D:\\images\\%s.jpg' % x)

x = x + 1

html = getHtml("http://www.qiushibaike.com/imgrank/";)

getImg(html)

以上通过python抓取网站的图片并下载到本地的方法就是小编给大家分享的全部内容。希望能给大家一个参考,也希望大家多多支持。

时间:2018-05-20

Python使用proxy抓取网站图片(多线程)

一.功能说明:1. 多线程抓取代理服务器的方法,以及多线程验证代理服务器 ps 代理服务器抓取自(测试只选了8个页面)< @2.抓取网站的图片地址,多线程随机选择代理服务器下载图片二.实现代码复制代码如下:#!/usr/bin/env python #coding:utf-8 import urllib2import reimport threadingimport timeimport random rawProxyList = []ch

Python使用scrapy抓取网站站点地图信息

本文中的一个示例描述了 Python 如何使用 scrapy 来捕获 网站 站点地图信息。分享给大家,供大家参考。具体如下: import re from scrapy.spider import BaseSpider from scrapy import log from scrapy.utils.response import body_or_str from scrapy.http import Request from scrapy.selector import HtmlXPathSelector c

Python爬取链接网站详解

在本文 文章 中,您将学习将这些基本方法集成到一个更灵活的 网站 爬虫中,该爬虫可以跟踪任何遵循特定 URL 模式的链接。这个爬虫非常适合从网站中抓取所有数据的item,而不是从特定搜索结果或页面列表抓取数据的item。它也非常适合 网站 页面组织不良或非常分散的情况。这些类型的爬虫不需要上一节中使用的定位链接的结构化方法来爬取搜索页面,因此不需要在网站对象中收录描述搜索页面的属性。但是因为爬虫不知道该做什么去寻找链接的位置,所以需要一些规则来告诉它选择哪个页面

Python爬虫包BeautifulSoup递归爬取实例详解

Python爬虫包BeautifulSoup递归爬虫示例详细总结:爬虫的主要目的是沿网络爬取所需内容。它们的本质是一个递归过程。他们首先需要获取网页的内容,然后分析网页的内容,找到另一个网址,然后得到这个网址的网页内容,重复这个过程。我们以维基百科为例。我们希望将维基百科中的所有 Kevin Bacon 条目链接到其他条目。提取出来。# -*- coding: utf-8 -*- # @Author: HaonanWu # @Date: 2016-12-25 10:

Thinkphp 捕获网站 的内容并保存到本地实例。

thinkphp 抓取网站 的内容并保存到本地。我需要写一个这样的例子,从电子教科书网络下载一本电子书。电子教科书网的电子书把书的每一页都当作一个图片,然后一本书有很多图片,我需要批量下载图片。下面是代码部分: public function download() {$http = new \Org\Net\Http(); $url_pref = "" ; $localUrl =

Python实现多线程网络爬虫功能实例详解

<p>本文介绍了多线程网络爬虫功能的Python实现。分享出来供大家参考,如下: 最近一直在做网络爬虫相关的事情。看了看开源C++写的larbin爬虫,仔细看了里面的设计。一些关键技术的思路和实现。1.larbin URL de-reuse 非常高效的bloom filter算法:

php抓取网页所有图片(维易:PHP应用本文实例讲述php获取网页里所有图片)

网站优化 • 优采云 发表了文章 • 0 个评论 • 44 次浏览 • 2021-12-10 07:19

《PHP实战:PHP如何获取网页中的所有图片并存入数组》要点:

本文介绍了PHP实战:PHP获取一个网页中的所有图片,并存储在一个数组中。我希望它对你有用。如果您有任何问题,可以联系我们。

本文以PHP应用为例,介绍了PHP如何获取网页中的所有图片,并将其存储在数组中。分享它们以供您参考。详情如下:

PHP应用

$images = array();

preg_match_all('/(img|src)=("|')[^"'>]+/i', $data, $media);

unset($data);

$data=preg_replace('/(img|src)("|'|="|=')(.*)/i',"$3",$media[0]);

foreach($data as $url)

{

$info = pathinfo($url);

if (isset($info['extension']))

{

if (($info['extension'] == 'jpg') ||

($info['extension'] == 'jpeg') ||

($info['extension'] == 'gif') ||

($info['extension'] == 'png'))

array_push($images, $url);

}

}

PHP 应用程序希望本文对您的 PHP 编程有所帮助。

欢迎参与“PHP实战:PHP获取网页中的所有图片并存储在数组中”的讨论,分享您的想法,微易PHP学院为您提供专业教程。 查看全部

php抓取网页所有图片(维易:PHP应用本文实例讲述php获取网页里所有图片)

《PHP实战:PHP如何获取网页中的所有图片并存入数组》要点:

本文介绍了PHP实战:PHP获取一个网页中的所有图片,并存储在一个数组中。我希望它对你有用。如果您有任何问题,可以联系我们。

本文以PHP应用为例,介绍了PHP如何获取网页中的所有图片,并将其存储在数组中。分享它们以供您参考。详情如下:

PHP应用

$images = array();

preg_match_all('/(img|src)=("|')[^"'>]+/i', $data, $media);

unset($data);

$data=preg_replace('/(img|src)("|'|="|=')(.*)/i',"$3",$media[0]);

foreach($data as $url)

{

$info = pathinfo($url);

if (isset($info['extension']))

{

if (($info['extension'] == 'jpg') ||

($info['extension'] == 'jpeg') ||

($info['extension'] == 'gif') ||

($info['extension'] == 'png'))

array_push($images, $url);

}

}

PHP 应用程序希望本文对您的 PHP 编程有所帮助。

欢迎参与“PHP实战:PHP获取网页中的所有图片并存储在数组中”的讨论,分享您的想法,微易PHP学院为您提供专业教程。

php抓取网页所有图片( 可爱的Python(哲思社区)插图版,文字版[PDF])

网站优化 • 优采云 发表了文章 • 0 个评论 • 57 次浏览 • 2022-03-24 09:05

可爱的Python(哲思社区)插图版,文字版[PDF])

可爱的Python(哲学社区)图解版、文字版[PDF]

现在网上有很多用python2写的爬虫爬取网页图片的例子,但是不适合新手(新手使用python3环境,不兼容python2),

所以我用Python3语法写了一个简单的抓取网页图片的例子,希望对大家有帮助,也希望大家批评指正。

import urllib.request

import re

import os

import urllib

#根据给定的网址来获取网页详细信息,得到的html就是网页的源代码

def getHtml(url):

page = urllib.request.urlopen(url)

html = page.read()

return html.decode('UTF-8')

def getImg(html):

reg = r'src="(.+?\.jpg)" pic_ext'

imgre = re.compile(reg)

imglist = imgre.findall(html)#表示在整个网页中过滤出所有图片的地址,放在imglist中

x = 0

path = 'D:\\test'

# 将图片保存到D:\\test文件夹中,如果没有test文件夹则创建

if not os.path.isdir(path):

os.makedirs(path)

paths = path+'\\' #保存在test路径下

for imgurl in imglist:

urllib.request.urlretrieve(imgurl,'{0}{1}.jpg'.format(paths,x)) #打开imglist中保存的图片网址,并下载图片保存在本地,format格式化字符串

x = x + 1

return imglist

html = getHtml("http://tieba.baidu.com/p/2460150866")#获取该网址网页详细信息,得到的html就是网页的源代码

print (getImg(html)) #从网页源代码中分析并下载保存图片

以上就是本文的全部内容,希望对大家的学习有所帮助,也希望大家多多支持古谷店计划。

转载请注明: 谷谷店程序 » Python3简单爬虫爬取网页图片代码示例 查看全部

php抓取网页所有图片(

可爱的Python(哲思社区)插图版,文字版[PDF])

可爱的Python(哲学社区)图解版、文字版[PDF]

现在网上有很多用python2写的爬虫爬取网页图片的例子,但是不适合新手(新手使用python3环境,不兼容python2),

所以我用Python3语法写了一个简单的抓取网页图片的例子,希望对大家有帮助,也希望大家批评指正。

import urllib.request

import re

import os

import urllib

#根据给定的网址来获取网页详细信息,得到的html就是网页的源代码

def getHtml(url):

page = urllib.request.urlopen(url)

html = page.read()

return html.decode('UTF-8')

def getImg(html):

reg = r'src="(.+?\.jpg)" pic_ext'

imgre = re.compile(reg)

imglist = imgre.findall(html)#表示在整个网页中过滤出所有图片的地址,放在imglist中

x = 0

path = 'D:\\test'

# 将图片保存到D:\\test文件夹中,如果没有test文件夹则创建

if not os.path.isdir(path):

os.makedirs(path)

paths = path+'\\' #保存在test路径下

for imgurl in imglist:

urllib.request.urlretrieve(imgurl,'{0}{1}.jpg'.format(paths,x)) #打开imglist中保存的图片网址,并下载图片保存在本地,format格式化字符串

x = x + 1

return imglist

html = getHtml("http://tieba.baidu.com/p/2460150866";)#获取该网址网页详细信息,得到的html就是网页的源代码

print (getImg(html)) #从网页源代码中分析并下载保存图片

以上就是本文的全部内容,希望对大家的学习有所帮助,也希望大家多多支持古谷店计划。

转载请注明: 谷谷店程序 » Python3简单爬虫爬取网页图片代码示例

php抓取网页所有图片(php抓取网页所有图片,然后解析..selenium+python)

网站优化 • 优采云 发表了文章 • 0 个评论 • 56 次浏览 • 2022-03-18 16:11

php抓取网页所有图片,然后解析...selenium可以用来学习用浏览器做事,

如果是网页制作或者抓取,其实aws+python/java/php就够了,如果是页面定制化,实时抓取和并发处理,可以考虑专门写一个爬虫,twitter/facebook/tomcat+python/go/java,其实java也可以实现页面内抓取,不过要实现网络请求接口,用浏览器的webdriver还是很容易的,可以用来研究,对dom反编译也不是很懂,所以不好说,其实写一个爬虫方便处理网络请求处理后续工作,远比写一个页面抓取高效多了。

目前专职研究网络请求及dom反编译的,推荐下whoisdebug和virtualdom,全面了解内部业务逻辑代码和流程,比后端代码研究开发之类的更有前途。

我懂题主意思。而且我也是写爬虫的,这段时间我要开发一款chrome的浏览器插件。我觉得学习的话。可以先入门python,多写些js代码。后期可以抽时间学习web开发,比如项目实战。都是很好的方向,有问题在知乎上提,会得到很多回答。不懂再问。

问题已删

各位刚从信息安全的坑里跳出来的大咖,你们这样满天飞的日新月异是要害死自己的:1.外行别学技术。2.信息安全不是互联网技术。3.我承认我这段时间是混饭吃,但是看到人力和项目放在一起一混就是一年多的时间,我真心心疼大伙。不是所有人都值得你一辈子做一份踏实的工作。 查看全部

php抓取网页所有图片(php抓取网页所有图片,然后解析..selenium+python)

php抓取网页所有图片,然后解析...selenium可以用来学习用浏览器做事,

如果是网页制作或者抓取,其实aws+python/java/php就够了,如果是页面定制化,实时抓取和并发处理,可以考虑专门写一个爬虫,twitter/facebook/tomcat+python/go/java,其实java也可以实现页面内抓取,不过要实现网络请求接口,用浏览器的webdriver还是很容易的,可以用来研究,对dom反编译也不是很懂,所以不好说,其实写一个爬虫方便处理网络请求处理后续工作,远比写一个页面抓取高效多了。

目前专职研究网络请求及dom反编译的,推荐下whoisdebug和virtualdom,全面了解内部业务逻辑代码和流程,比后端代码研究开发之类的更有前途。

我懂题主意思。而且我也是写爬虫的,这段时间我要开发一款chrome的浏览器插件。我觉得学习的话。可以先入门python,多写些js代码。后期可以抽时间学习web开发,比如项目实战。都是很好的方向,有问题在知乎上提,会得到很多回答。不懂再问。

问题已删

各位刚从信息安全的坑里跳出来的大咖,你们这样满天飞的日新月异是要害死自己的:1.外行别学技术。2.信息安全不是互联网技术。3.我承认我这段时间是混饭吃,但是看到人力和项目放在一起一混就是一年多的时间,我真心心疼大伙。不是所有人都值得你一辈子做一份踏实的工作。

php抓取网页所有图片(如何利用ThinkPHP来实现所有图片加上水印的图片水印? )

网站优化 • 优采云 发表了文章 • 0 个评论 • 49 次浏览 • 2022-03-13 14:16

)

在做网站的时候,需要在文章中的所有图片上加上logo,如何使用ThinkPHP来实现。

ThinkPHP为我们提供了一个很好的图片处理类,给文章中的所有图片加水印的思路,上传的图片文件都保存在一个文件夹中,我只需要获取文件夹和子文件把下面所有的图片都文件夹,遍历一次,加个水印,所以目前的难点就是如何获取文件中的图片,遍历一次。【二维数组的遍历会出现在ImagesController控制器中】;因此,加水印图片的问题转化为使用PHP遍历目录输出目录及其下所有图片文件

//遍历目录输出目录及其下的所有文件 利用函数的递归解决

function my_scandir($dir){

$files=array();

if(is_dir($dir)){

if($handle=opendir($dir)){

while(($file=readdir($handle))!==false){

if($file!='.' && $file!=".."){

if(is_dir($dir."/".$file)){

$files[$file]=my_scandir($dir."/".$file);

}else{

$files[]=$dir."/".$file; //获取文件的完全路径

$filesnames[]=$file; //获取文件的文件名称

}

}

}

}

}

closedir($handle);

return $files;

//return $filesnames;

}

下一步是处理图像水印的问题。

//对于一维数组的遍历

$picArr = my_scandir('./Public/Uploads/txtPig');//返回的是数组格式的数据

dump($picArr);

foreach ($picArr as $value) {

$image = new \Think\Image();

$image->open($value)->text('pengjun','./Public/consola.ttf',20,'#000000',\Think\Image::IMAGE_WATER_SOUTHEAST)->save($value);

}

//php二维数组的遍历,利用两个foreach()遍历即可

$picArr2 = my_scandir('./Public/plugins\kindeditor\attached\image');

dump($picArr2);

foreach ($picArr2 as $key => $value1) {

foreach ($value1 as $key2 => $value2) {

$image = new \Think\Image();

$image->open($value2)->text('pengjun','./Public/consola.ttf',20,'#000000',\Think\Image::IMAGE_WATER_SOUTHEAST)->save($value2);

}

} 查看全部

php抓取网页所有图片(如何利用ThinkPHP来实现所有图片加上水印的图片水印?

)

在做网站的时候,需要在文章中的所有图片上加上logo,如何使用ThinkPHP来实现。

ThinkPHP为我们提供了一个很好的图片处理类,给文章中的所有图片加水印的思路,上传的图片文件都保存在一个文件夹中,我只需要获取文件夹和子文件把下面所有的图片都文件夹,遍历一次,加个水印,所以目前的难点就是如何获取文件中的图片,遍历一次。【二维数组的遍历会出现在ImagesController控制器中】;因此,加水印图片的问题转化为使用PHP遍历目录输出目录及其下所有图片文件

//遍历目录输出目录及其下的所有文件 利用函数的递归解决

function my_scandir($dir){

$files=array();

if(is_dir($dir)){

if($handle=opendir($dir)){

while(($file=readdir($handle))!==false){

if($file!='.' && $file!=".."){

if(is_dir($dir."/".$file)){

$files[$file]=my_scandir($dir."/".$file);

}else{

$files[]=$dir."/".$file; //获取文件的完全路径

$filesnames[]=$file; //获取文件的文件名称

}

}

}

}

}

closedir($handle);

return $files;

//return $filesnames;

}

下一步是处理图像水印的问题。

//对于一维数组的遍历

$picArr = my_scandir('./Public/Uploads/txtPig');//返回的是数组格式的数据

dump($picArr);

foreach ($picArr as $value) {

$image = new \Think\Image();

$image->open($value)->text('pengjun','./Public/consola.ttf',20,'#000000',\Think\Image::IMAGE_WATER_SOUTHEAST)->save($value);

}

//php二维数组的遍历,利用两个foreach()遍历即可

$picArr2 = my_scandir('./Public/plugins\kindeditor\attached\image');

dump($picArr2);

foreach ($picArr2 as $key => $value1) {

foreach ($value1 as $key2 => $value2) {

$image = new \Think\Image();

$image->open($value2)->text('pengjun','./Public/consola.ttf',20,'#000000',\Think\Image::IMAGE_WATER_SOUTHEAST)->save($value2);

}

}

php抓取网页所有图片(php抓取所有图片可以这样做你可以抓取网页,看我头像php来讲)

网站优化 • 优采云 发表了文章 • 0 个评论 • 56 次浏览 • 2022-03-13 10:03

php抓取网页所有图片可以这样做

你可以抓取网页,然后截图,可以用vba来完成,

看我头像

php来讲,用fiddler可以。vs来讲,可以用插件bootstrap3。maxthon来讲,这就是mysql相关的东西了。

vba在web中抓取php数据库。你可以试试。就是那个截图的插件,mysql可以用mysqlscript比如这样:thismodelissimplifyingaresourcetomapbetweentheexamples.let'sputthedataintomysqlscript.contentsmakeglobalshowbelow:'user_name'=>'*。 查看全部

php抓取网页所有图片(php抓取所有图片可以这样做你可以抓取网页,看我头像php来讲)

php抓取网页所有图片可以这样做

你可以抓取网页,然后截图,可以用vba来完成,

看我头像

php来讲,用fiddler可以。vs来讲,可以用插件bootstrap3。maxthon来讲,这就是mysql相关的东西了。

vba在web中抓取php数据库。你可以试试。就是那个截图的插件,mysql可以用mysqlscript比如这样:thismodelissimplifyingaresourcetomapbetweentheexamples.let'sputthedataintomysqlscript.contentsmakeglobalshowbelow:'user_name'=>'*。

php抓取网页所有图片(通州网站优化,网站地图的格式有哪些呢??)

网站优化 • 优采云 发表了文章 • 0 个评论 • 60 次浏览 • 2022-02-26 17:15

网站地图页面也称为网站内部导航页面。此页面收录 网站 中最重要的页面链接。用户和搜索引擎都可以通过这个页面快速获取网站。优化了@>通州网站中的重要内容。

<p>网站地图是所有网站 链接的容器。很多网站链接层级都比较深,通州优化网站,蜘蛛很难爬,但是只要有网站图,蜘蛛就可以轻松进入 查看全部

php抓取网页所有图片(通州网站优化,网站地图的格式有哪些呢??)

网站地图页面也称为网站内部导航页面。此页面收录 网站 中最重要的页面链接。用户和搜索引擎都可以通过这个页面快速获取网站。优化了@>通州网站中的重要内容。

<p>网站地图是所有网站 链接的容器。很多网站链接层级都比较深,通州优化网站,蜘蛛很难爬,但是只要有网站图,蜘蛛就可以轻松进入

php抓取网页所有图片(什么是网页抓取?你是否曾经需要从一个没有提供API的站点获取信息)

网站优化 • 优采云 发表了文章 • 0 个评论 • 91 次浏览 • 2022-02-25 05:06

什么是网页抓取?

您是否曾经需要从不提供 API 的站点获取信息?我们可以通过抓取网页然后从目标 网站 的 HTML 中获取我们想要的信息来解决这个问题。当然,我们也可以手动提取这些信息,但是手动提取很繁琐。因此,使用爬虫自动执行此过程会更有效。

在本教程中,我们将从 Pexels 抓取一些猫的照片。这个 网站 提供高质量的免费库存图片。他们提供 API,但这些 API 的频率限制为 200 个请求/小时。

发起并发请求

使用异步 PHP 进行网页抓取(与使用同步方法相比)的最大好处是可以在更短的时间内完成更多的工作。使用异步 PHP 允许我们一次请求尽可能多的页面,而不是一次请求一个页面并等待结果返回。所以一旦请求结果回来,我们就可以开始处理了。

首先,我们从 GitHub 拉取名为 Buzz-react 的异步 HTTP 客户端的代码——它是一个简单的基于 ReactPHP 的异步 HTTP 客户端,专用于同时处理大量 HTTP 请求:

composer require clue/buzz-react

复制代码

现在,我们可以在 pexels 上请求图像页面:

<p> 查看全部

php抓取网页所有图片(什么是网页抓取?你是否曾经需要从一个没有提供API的站点获取信息)

什么是网页抓取?

您是否曾经需要从不提供 API 的站点获取信息?我们可以通过抓取网页然后从目标 网站 的 HTML 中获取我们想要的信息来解决这个问题。当然,我们也可以手动提取这些信息,但是手动提取很繁琐。因此,使用爬虫自动执行此过程会更有效。

在本教程中,我们将从 Pexels 抓取一些猫的照片。这个 网站 提供高质量的免费库存图片。他们提供 API,但这些 API 的频率限制为 200 个请求/小时。

发起并发请求

使用异步 PHP 进行网页抓取(与使用同步方法相比)的最大好处是可以在更短的时间内完成更多的工作。使用异步 PHP 允许我们一次请求尽可能多的页面,而不是一次请求一个页面并等待结果返回。所以一旦请求结果回来,我们就可以开始处理了。

首先,我们从 GitHub 拉取名为 Buzz-react 的异步 HTTP 客户端的代码——它是一个简单的基于 ReactPHP 的异步 HTTP 客户端,专用于同时处理大量 HTTP 请求:

composer require clue/buzz-react

复制代码

现在,我们可以在 pexels 上请求图像页面:

<p>

php抓取网页所有图片(查看更多写博客爬虫入门之爬虫(gt)(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 225 次浏览 • 2022-02-21 03:28

阿里云 > 云栖社区 > 主题图 > P > php爬虫抓图

推荐活动:

更多优惠>

当前话题:php爬虫抓取图片并添加到采集夹

相关话题:

php爬虫爬取图片相关博客看更多博文

爬虫简介爬虫概述和urllib库(一)

作者:蓝の流星 VIP1588 浏览评论:03年前

1 爬虫概述(1)互联网爬虫是根据Url爬取网页并获取有用信息的程序(2)抓取网页和解析数据的核心任务难点:爬虫与反抗之间的博弈) -crawlers(3)爬虫语言php多进程多线程支持java较差。目前java爬虫作业需求旺盛,但代码臃肿,重构成本高。

阅读全文

Python - 爬虫

作者:刘新伟 1070 浏览评论:04年前

参考资料 网络爬虫(也称为网络蜘蛛、网络机器人,在 FOAF 社区中,更常被称为网络追逐者)是一种程序或脚本,它根据一定的规则自动从万维网上爬取信息。其他不太常用的名称是 ant、autoindex、emulator 或 worm。其实通俗的说就是获取

阅读全文

百万级爬虫用php抓取和分析用户数据知乎

作者:Know Who With 1115 Viewers 评论:04 年前

本次抓取了110万用户数据,数据分析结果如下: 从结果可以看出,知乎的男女分布分别为61.7和38.3%。对于一个知识型和问答型的社区来说,已经很不错了。如果有更多的女孩,知乎几乎可以成为一个婚姻和爱情社区,开玩笑的。顺便说一句,在《爬取3000万QQ用户数据,挖出花钱》

阅读全文

PHP开发:使用PHP爬取百万知乎用户及知识点笔记

作者:沃克武松1184 浏览评论:04年前

开发前准备 安装Linux系统(Ubuntu14.04),在VMWare虚拟机下安装Ubuntu;安装PHP5.6或以上;安装curl、pcntl扩展。使用PHP curl扩展抓取页面数据 PHP 的 curl 扩展是 PHP 支持的,允许您与各种服务器交互

阅读全文

PHP爬虫:百万级知乎用户数据爬取分析

作者:沃克武松 2012 浏览评论:04年前

这次抓到110万用户数据,数据分析结果如下: 开发前的准备 安装Linux系统(Ubuntu14.04),在VMWare虚拟机下安装一个Ubuntu;安装PHP5.6或以上;安装MySQL5.5或以上;安装curl、pcntl扩展。使用PH

阅读全文

玩C必备的19个Java开源网络爬虫

作者:沃克武松 1249人浏览评论:04年前

网络爬虫(也称为网络蜘蛛、网络机器人,在 FOAF 社区中,更常被称为网页追逐者)是根据一定的规则自动爬取万维网上信息的程序或脚本。其他不太常用的名称是 ant、autoindex、emulator 或 worm。今天给大家介绍19款Java开源网络爬虫。

阅读全文

Python爬虫框架-PySpider

作者:shadowcat7965 浏览人数评论:04年前

From: From: PySpider PySpider github地址PySpider官方文档PySpi

阅读全文

构建网络爬虫?太简单

作者:悠悠然然 1953 观众评论:05年前

网络爬虫一般用于全文检索或内容获取。Tiny 框架对此也有有限的支持。虽然功能不多,但是做全文搜索或者从网页获取数据都非常方便。框架特点 强大的节点过滤能力 支持post和get两种数据提交方式,避免网页重复处理功能 支持多站点内容爬取功能

阅读全文 查看全部

php抓取网页所有图片(查看更多写博客爬虫入门之爬虫(gt)(组图))

阿里云 > 云栖社区 > 主题图 > P > php爬虫抓图

推荐活动:

更多优惠>

当前话题:php爬虫抓取图片并添加到采集夹

相关话题:

php爬虫爬取图片相关博客看更多博文

爬虫简介爬虫概述和urllib库(一)

作者:蓝の流星 VIP1588 浏览评论:03年前

1 爬虫概述(1)互联网爬虫是根据Url爬取网页并获取有用信息的程序(2)抓取网页和解析数据的核心任务难点:爬虫与反抗之间的博弈) -crawlers(3)爬虫语言php多进程多线程支持java较差。目前java爬虫作业需求旺盛,但代码臃肿,重构成本高。

阅读全文

Python - 爬虫

作者:刘新伟 1070 浏览评论:04年前

参考资料 网络爬虫(也称为网络蜘蛛、网络机器人,在 FOAF 社区中,更常被称为网络追逐者)是一种程序或脚本,它根据一定的规则自动从万维网上爬取信息。其他不太常用的名称是 ant、autoindex、emulator 或 worm。其实通俗的说就是获取

阅读全文

百万级爬虫用php抓取和分析用户数据知乎

作者:Know Who With 1115 Viewers 评论:04 年前

本次抓取了110万用户数据,数据分析结果如下: 从结果可以看出,知乎的男女分布分别为61.7和38.3%。对于一个知识型和问答型的社区来说,已经很不错了。如果有更多的女孩,知乎几乎可以成为一个婚姻和爱情社区,开玩笑的。顺便说一句,在《爬取3000万QQ用户数据,挖出花钱》

阅读全文

PHP开发:使用PHP爬取百万知乎用户及知识点笔记

作者:沃克武松1184 浏览评论:04年前

开发前准备 安装Linux系统(Ubuntu14.04),在VMWare虚拟机下安装Ubuntu;安装PHP5.6或以上;安装curl、pcntl扩展。使用PHP curl扩展抓取页面数据 PHP 的 curl 扩展是 PHP 支持的,允许您与各种服务器交互

阅读全文

PHP爬虫:百万级知乎用户数据爬取分析

作者:沃克武松 2012 浏览评论:04年前

这次抓到110万用户数据,数据分析结果如下: 开发前的准备 安装Linux系统(Ubuntu14.04),在VMWare虚拟机下安装一个Ubuntu;安装PHP5.6或以上;安装MySQL5.5或以上;安装curl、pcntl扩展。使用PH

阅读全文

玩C必备的19个Java开源网络爬虫

作者:沃克武松 1249人浏览评论:04年前

网络爬虫(也称为网络蜘蛛、网络机器人,在 FOAF 社区中,更常被称为网页追逐者)是根据一定的规则自动爬取万维网上信息的程序或脚本。其他不太常用的名称是 ant、autoindex、emulator 或 worm。今天给大家介绍19款Java开源网络爬虫。

阅读全文

Python爬虫框架-PySpider

作者:shadowcat7965 浏览人数评论:04年前

From: From: PySpider PySpider github地址PySpider官方文档PySpi

阅读全文

构建网络爬虫?太简单

作者:悠悠然然 1953 观众评论:05年前

网络爬虫一般用于全文检索或内容获取。Tiny 框架对此也有有限的支持。虽然功能不多,但是做全文搜索或者从网页获取数据都非常方便。框架特点 强大的节点过滤能力 支持post和get两种数据提交方式,避免网页重复处理功能 支持多站点内容爬取功能

阅读全文

php抓取网页所有图片( 有一个函数可以获取网页文件的所有meta标签,该函数就是get_meta )

网站优化 • 优采云 发表了文章 • 0 个评论 • 50 次浏览 • 2022-02-15 22:06

有一个函数可以获取网页文件的所有meta标签,该函数就是get_meta

)

php get_meta_tags 获取网页文件的元信息

时间:2016-06-22

php有一个函数可以获取一个网页文件的所有meta标签,函数是get_meta_tags,函数最后返回一个数组。本文章将给大家介绍php get_meta_tags的使用示例。需要的朋友可以参考一下。

比如我们要获取这个网站首页的meta标签信息,可以直接使用get_meta_tags函数来获取:

最终输出结果

Array

(

[viewport] => width=device-width, initial-scale=1.0, maximum-scale=1.0, user-scalable=no

[keywords] => 码农教程,编程入门教程,码农网,码农,编程入门,编程学习,编程入门网,java,php,javascript,jquery,html,css,mysql,数据库

[description] => 码农教程旨在为码农们提供免费的IT编程入门教程和编程学习平台,本码农网涵盖php、java、mysql、html、css、javascript、jquery等流行的编程入门教程。

) 查看全部

php抓取网页所有图片(

有一个函数可以获取网页文件的所有meta标签,该函数就是get_meta

)

php get_meta_tags 获取网页文件的元信息

时间:2016-06-22

php有一个函数可以获取一个网页文件的所有meta标签,函数是get_meta_tags,函数最后返回一个数组。本文章将给大家介绍php get_meta_tags的使用示例。需要的朋友可以参考一下。

比如我们要获取这个网站首页的meta标签信息,可以直接使用get_meta_tags函数来获取:

最终输出结果

Array

(

[viewport] => width=device-width, initial-scale=1.0, maximum-scale=1.0, user-scalable=no

[keywords] => 码农教程,编程入门教程,码农网,码农,编程入门,编程学习,编程入门网,java,php,javascript,jquery,html,css,mysql,数据库

[description] => 码农教程旨在为码农们提供免费的IT编程入门教程和编程学习平台,本码农网涵盖php、java、mysql、html、css、javascript、jquery等流行的编程入门教程。

)

php抓取网页所有图片(什么?你问Icon是什么?Icon怎么设置Icon?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 97 次浏览 • 2022-02-11 13:30

一般情况下,做网站的人都会在自己的网站上加一个Icon。浏览器上长长的一排标签,如果用 Icon 来区分,会更加醒目。现在想找一个没有Icon的网站已经不容易了,可见一个没有Icon的网站是多么的业余。“什么?你问Icon是什么?来吧,这里是谈技术的地方!”

如果您想知道如何获取 Icon,则必须弄清楚如何设置 Icon。先讨论设置Icon,然后介绍获取Icon,并提供对应的Java代码供参考。

一.设置网站图标

Icon有两种设置方式:

1. 看看我们专业的博客园,看到灰色的部分,head标签里有link标签,设置rel为“快捷图标”,href为Icon的位置,type为实际图标类型没问题。这个 Icon 文件不必命名为 favicon.ico,也可以选择 png 等其他格式的图片。

2. 如果用第一种方法,每页都写一个链接很麻烦。它可能由模板之类的东西自动生成。我不明白这一点。如果浏览器发现 html 中没有写入 Icon 位置,会自动到 网站 根目录,尝试读取 favicon.ico 文件。再看看我们的专业博客园,看到,图标显示出来了。注意:根目录中的文件必须命名为 favicon.ico。考虑到浏览器的兼容性,大部分网站不仅指定了Icon在html中的位置,而且将Icon文件存放在网站的根目录下。

二. 获取网站图标

知道如何设置图标,获取图标很容易。解析html比较麻烦,可以直接到网站根目录,尝试阅读favicon.ico。如果不行,再解析一下html(也就是说,我试过很多常见的网站,都可以从根目录下读取,真的不容易找到一个能做到的网站不在根目录下存放Icon,这时候就想到了12306,试了下还是不行,事情并没有我想的那么简单,12306会精彩到你想不到。思路是这样的,很简单,但是在实现的过程中会有很多细节。

1.域名+favicon.ico 通常就够了

2.域名+目录+favicon.ico 大部分也可以满足

3.通过api获取

4.真的没有默认的回报 查看全部

php抓取网页所有图片(什么?你问Icon是什么?Icon怎么设置Icon?)

一般情况下,做网站的人都会在自己的网站上加一个Icon。浏览器上长长的一排标签,如果用 Icon 来区分,会更加醒目。现在想找一个没有Icon的网站已经不容易了,可见一个没有Icon的网站是多么的业余。“什么?你问Icon是什么?来吧,这里是谈技术的地方!”

如果您想知道如何获取 Icon,则必须弄清楚如何设置 Icon。先讨论设置Icon,然后介绍获取Icon,并提供对应的Java代码供参考。

一.设置网站图标

Icon有两种设置方式:

1. 看看我们专业的博客园,看到灰色的部分,head标签里有link标签,设置rel为“快捷图标”,href为Icon的位置,type为实际图标类型没问题。这个 Icon 文件不必命名为 favicon.ico,也可以选择 png 等其他格式的图片。

2. 如果用第一种方法,每页都写一个链接很麻烦。它可能由模板之类的东西自动生成。我不明白这一点。如果浏览器发现 html 中没有写入 Icon 位置,会自动到 网站 根目录,尝试读取 favicon.ico 文件。再看看我们的专业博客园,看到,图标显示出来了。注意:根目录中的文件必须命名为 favicon.ico。考虑到浏览器的兼容性,大部分网站不仅指定了Icon在html中的位置,而且将Icon文件存放在网站的根目录下。

二. 获取网站图标

知道如何设置图标,获取图标很容易。解析html比较麻烦,可以直接到网站根目录,尝试阅读favicon.ico。如果不行,再解析一下html(也就是说,我试过很多常见的网站,都可以从根目录下读取,真的不容易找到一个能做到的网站不在根目录下存放Icon,这时候就想到了12306,试了下还是不行,事情并没有我想的那么简单,12306会精彩到你想不到。思路是这样的,很简单,但是在实现的过程中会有很多细节。

1.域名+favicon.ico 通常就够了

2.域名+目录+favicon.ico 大部分也可以满足

3.通过api获取

4.真的没有默认的回报

php抓取网页所有图片( 我一直想用PythonandSelenium创建一个网页爬虫,但从来没有实现它)

网站优化 • 优采云 发表了文章 • 0 个评论 • 54 次浏览 • 2022-02-09 20:03

我一直想用PythonandSelenium创建一个网页爬虫,但从来没有实现它)

我一直想用 Python 和 Selenium 创建一个网络爬虫,但一直没有解决。几天前,我决定试一试,这听起来可能很复杂,但编写代码从 Unsplash 中抓取一些漂亮的图像是很容易的。

一个简单的图片爬虫的组件一个简单的图片爬虫的制作

一切都安装好了吗?好的!按照我们的代码,我将开始解释我们每个爬虫成分的作用。

首先,我们将结合 Selenium webdriver 和 geckodriver 打开一个适合我们的浏览器窗口。首先,在Pycharm中创建一个项目,根据你的系统下载最新的geckodriver,打开下载的zip文件,将geckodriver文件放到你的项目文件夹中。Geckodriver 是 Selenium 控制 Firefox 的基础,所以我们需要把它放在我们的项目文件夹中,这样我们才能使用浏览器。

接下来我们要做的是在我们的代码中导入 Selenium 的 webdriver 并连接到我们要连接的 URL,所以让我们这样做:

from selenium import webdriver

# 你想打开的url地址

url = "https://unsplash.com"

# 用Selenium的webdriver去打开页面

driver = webdriver.Firefox(executable_path=r'geckodriver.exe')

driver.get(url)

远程控制的 Firefox 窗口

很简单,对吧?如果你做的一切都正确,你已经克服了困难,你应该看到一个类似于上面显示的浏览器窗口。

接下来,我们应该向下滚动页面,以便在下载之前可以加载更多图像。我们还需要等待几秒钟,以防网络连接缓慢,图片没有完全加载。由于 Unsplash 是基于 React 构建的,5 秒的等待似乎是一个合适的时间,所以我们使用 time 包进行等待操作。我们还需要使用一些 Javascript 代码来滚动页面。

--- 我们将使用 window.scrollTo() 来做到这一点。把它们放在一起,你应该得到这样的代码:

unscrape.py

import time

from selenium import webdriver

url = "https://unsplash.com"

driver = webdriver.Firefox(executable_path=r'geckodriver.exe')

driver.get(url)

# 滚动页面,然后等待5秒

driver.execute_script("window.scrollTo(0,1000);")

time.sleep(5)

滚动页面并等待 5 秒

测试完上面的代码,你应该会看到浏览器向下滚动了一点,接下来我们需要做的是在网页上找到我们要下载的那些图像。解析recat生成的代码后,发现我们可以在页面代码中使用CSS选择器来定位我们想要的图片。也许以后页面的具体布局和代码可能会发生变化,但是在我写代码的时候我们可以使用#gridMulti img选择器来获取屏幕上出现的所有项目

标签元素

我们可以使用这些标签元素的列表集合,但是我们想要的是每个标签元素的 src 属性。因此,我们可以遍历列表集合并获取它们:

unscrape.py

选择图像标签元素并打印它们的 URL

现在,要实际获取我们找到的图像,我们将使用 requests 包和 PIL 包的一部分 Image。我们还需要使用 io 包中的 BytesIO 将图像写入 ./images/ 文件夹,我们需要在项目文件夹中创建该文件夹。所以,为了把所有东西放在一起,我们需要向每个图像的 URL 发送一个 HTTP GET 请求,然后使用 Image 和 BytesIO,我们可以将图像存储在我们得到的响应中,这是一种方法:

unscrape.py

import requests

import time

from selenium import webdriver

from PIL import Image

from io import BytesIO

url = "https://unsplash.com"

driver = webdriver.Firefox(executable_path=r'geckodriver.exe')

driver.get(url)

driver.execute_script("window.scrollTo(0,1000);")

time.sleep(5)

image_elements = driver.find_elements_by_css_selector("#gridMulti img")

i = 0

for image_element in image_elements:

image_url = image_element.get_attribute("src")

# 发送一个HTTP的GET请求,在响应里面获取并存储图片

image_object = requests.get(image_url)

image = Image.open(BytesIO(image_object.content))

image.save("./images/image" + str(i) + "." + image.format, image.format)

i += 1

下载图片

下载一堆免费图像几乎是您所需要的。显然,除非您想制作图像原型或只需要获取随机图像,否则这个小爬虫并没有多大用处。所以我花了一些时间通过添加更多功能来改进它:

您可以(并且可能应该)尝试自己实现其中的一些功能。网络爬虫的完整版本可在此处获得。记得单独下载 geckodriver 并将其连接到您的项目,如 文章 开头所述。

限制、反思和未来改进

这个整体项目是一个非常简单的概念验证,用于查看网络爬虫是如何实现的,这意味着可以做很多事情来改进这个小工具:

本文所有译文仅作学习交流之用,转载请务必注明文章译者、出处及本文链接

我们的翻译工作遵循 CC 协议。如果我们的工作侵犯了您的权利,请及时与我们联系。 查看全部

php抓取网页所有图片(

我一直想用PythonandSelenium创建一个网页爬虫,但从来没有实现它)

我一直想用 Python 和 Selenium 创建一个网络爬虫,但一直没有解决。几天前,我决定试一试,这听起来可能很复杂,但编写代码从 Unsplash 中抓取一些漂亮的图像是很容易的。

一个简单的图片爬虫的组件一个简单的图片爬虫的制作

一切都安装好了吗?好的!按照我们的代码,我将开始解释我们每个爬虫成分的作用。

首先,我们将结合 Selenium webdriver 和 geckodriver 打开一个适合我们的浏览器窗口。首先,在Pycharm中创建一个项目,根据你的系统下载最新的geckodriver,打开下载的zip文件,将geckodriver文件放到你的项目文件夹中。Geckodriver 是 Selenium 控制 Firefox 的基础,所以我们需要把它放在我们的项目文件夹中,这样我们才能使用浏览器。

接下来我们要做的是在我们的代码中导入 Selenium 的 webdriver 并连接到我们要连接的 URL,所以让我们这样做:

from selenium import webdriver

# 你想打开的url地址

url = "https://unsplash.com"

# 用Selenium的webdriver去打开页面

driver = webdriver.Firefox(executable_path=r'geckodriver.exe')

driver.get(url)

远程控制的 Firefox 窗口

很简单,对吧?如果你做的一切都正确,你已经克服了困难,你应该看到一个类似于上面显示的浏览器窗口。

接下来,我们应该向下滚动页面,以便在下载之前可以加载更多图像。我们还需要等待几秒钟,以防网络连接缓慢,图片没有完全加载。由于 Unsplash 是基于 React 构建的,5 秒的等待似乎是一个合适的时间,所以我们使用 time 包进行等待操作。我们还需要使用一些 Javascript 代码来滚动页面。

--- 我们将使用 window.scrollTo() 来做到这一点。把它们放在一起,你应该得到这样的代码:

unscrape.py

import time

from selenium import webdriver

url = "https://unsplash.com"

driver = webdriver.Firefox(executable_path=r'geckodriver.exe')

driver.get(url)

# 滚动页面,然后等待5秒

driver.execute_script("window.scrollTo(0,1000);")

time.sleep(5)

滚动页面并等待 5 秒

测试完上面的代码,你应该会看到浏览器向下滚动了一点,接下来我们需要做的是在网页上找到我们要下载的那些图像。解析recat生成的代码后,发现我们可以在页面代码中使用CSS选择器来定位我们想要的图片。也许以后页面的具体布局和代码可能会发生变化,但是在我写代码的时候我们可以使用#gridMulti img选择器来获取屏幕上出现的所有项目

标签元素

我们可以使用这些标签元素的列表集合,但是我们想要的是每个标签元素的 src 属性。因此,我们可以遍历列表集合并获取它们:

unscrape.py

选择图像标签元素并打印它们的 URL

现在,要实际获取我们找到的图像,我们将使用 requests 包和 PIL 包的一部分 Image。我们还需要使用 io 包中的 BytesIO 将图像写入 ./images/ 文件夹,我们需要在项目文件夹中创建该文件夹。所以,为了把所有东西放在一起,我们需要向每个图像的 URL 发送一个 HTTP GET 请求,然后使用 Image 和 BytesIO,我们可以将图像存储在我们得到的响应中,这是一种方法:

unscrape.py

import requests

import time

from selenium import webdriver

from PIL import Image

from io import BytesIO

url = "https://unsplash.com"

driver = webdriver.Firefox(executable_path=r'geckodriver.exe')

driver.get(url)

driver.execute_script("window.scrollTo(0,1000);")

time.sleep(5)

image_elements = driver.find_elements_by_css_selector("#gridMulti img")

i = 0

for image_element in image_elements:

image_url = image_element.get_attribute("src")

# 发送一个HTTP的GET请求,在响应里面获取并存储图片

image_object = requests.get(image_url)

image = Image.open(BytesIO(image_object.content))

image.save("./images/image" + str(i) + "." + image.format, image.format)

i += 1

下载图片

下载一堆免费图像几乎是您所需要的。显然,除非您想制作图像原型或只需要获取随机图像,否则这个小爬虫并没有多大用处。所以我花了一些时间通过添加更多功能来改进它:

您可以(并且可能应该)尝试自己实现其中的一些功能。网络爬虫的完整版本可在此处获得。记得单独下载 geckodriver 并将其连接到您的项目,如 文章 开头所述。

限制、反思和未来改进

这个整体项目是一个非常简单的概念验证,用于查看网络爬虫是如何实现的,这意味着可以做很多事情来改进这个小工具:

本文所有译文仅作学习交流之用,转载请务必注明文章译者、出处及本文链接

我们的翻译工作遵循 CC 协议。如果我们的工作侵犯了您的权利,请及时与我们联系。

php抓取网页所有图片(一个在线采集工具的实现方法:1.打包下载图片教程)

网站优化 • 优采云 发表了文章 • 0 个评论 • 133 次浏览 • 2022-02-03 15:09

最近开发了一个在线采集工具,可以根据URL获取当前页面中的图片信息,比如图片地址、图片标签中的属性、表单中的下载请求页面包装 (zip)。的图片。有兴趣的朋友可以查看以下DEMO页面获取采集图片:

这个DEMO页面只实现了最基本的两部分:采集地址和包下载。它仍处于测试阶段,仍在更新中。希望大家发现问题及时反馈,成为大家采集图片的便捷工具。

根据不断的测试,未来可能会增加新的功能,比如自动调整图片大小、设置打包图片的命名规则、合并和分解图片等。. . . 无论如何,我想添加很多功能。如果你有什么好的建议,希望你能留言。

以下是如何实现该工具的现有功能:

1. 获取地址

该函数的主要作用是使用正则表达式匹配页面源代码中的图片地址。这里使用的正则表达式是:

/

/iU

首页通过PHP自带的read file函数获取请求页面的html代码,然后用正则表达式匹配里面的src地址。这里有两点需要注意:

通过以上两点的处理,获取网页源代码是没有问题的。唯一要做的就是使用正则表达式来匹配图像地址。

2. 打包下载图片

这个功能没什么好说的。网上有很多开源代码可以提供打包的功能。唯一需要做的就是读取从页面获取的图片信息,使用php函数读取图片,并添加到压缩包中。. 该功能将在未来代码开源时一起发布。

这个在线采集小工具可以帮助一些快速建站的站长快速下载同一页面的所有图片信息,补充自己网站的内容。其实很多开源项目已经有了采集的功能,比如DEDE的采集系统,但是对于一些用户来说,功能太强大了,就不会用了,而DEDE收到的资料by 采集 直接存入库中,对于一些只想看采集图片的用户来说还是不够的。

我觉得功能强大固然好,但是对于用户来说,方便和方便会有更大的用户群。希望大家在试用过这个小工具后,可以多提宝贵意见,让这个工具更好的为用户服务。

演示地址 查看全部

php抓取网页所有图片(一个在线采集工具的实现方法:1.打包下载图片教程)

最近开发了一个在线采集工具,可以根据URL获取当前页面中的图片信息,比如图片地址、图片标签中的属性、表单中的下载请求页面包装 (zip)。的图片。有兴趣的朋友可以查看以下DEMO页面获取采集图片:

这个DEMO页面只实现了最基本的两部分:采集地址和包下载。它仍处于测试阶段,仍在更新中。希望大家发现问题及时反馈,成为大家采集图片的便捷工具。

根据不断的测试,未来可能会增加新的功能,比如自动调整图片大小、设置打包图片的命名规则、合并和分解图片等。. . . 无论如何,我想添加很多功能。如果你有什么好的建议,希望你能留言。

以下是如何实现该工具的现有功能:

1. 获取地址

该函数的主要作用是使用正则表达式匹配页面源代码中的图片地址。这里使用的正则表达式是:

/

/iU

首页通过PHP自带的read file函数获取请求页面的html代码,然后用正则表达式匹配里面的src地址。这里有两点需要注意:

通过以上两点的处理,获取网页源代码是没有问题的。唯一要做的就是使用正则表达式来匹配图像地址。

2. 打包下载图片

这个功能没什么好说的。网上有很多开源代码可以提供打包的功能。唯一需要做的就是读取从页面获取的图片信息,使用php函数读取图片,并添加到压缩包中。. 该功能将在未来代码开源时一起发布。

这个在线采集小工具可以帮助一些快速建站的站长快速下载同一页面的所有图片信息,补充自己网站的内容。其实很多开源项目已经有了采集的功能,比如DEDE的采集系统,但是对于一些用户来说,功能太强大了,就不会用了,而DEDE收到的资料by 采集 直接存入库中,对于一些只想看采集图片的用户来说还是不够的。

我觉得功能强大固然好,但是对于用户来说,方便和方便会有更大的用户群。希望大家在试用过这个小工具后,可以多提宝贵意见,让这个工具更好的为用户服务。

演示地址

php抓取网页所有图片(视频教程_php技术交流_51cto学院|在线学习教程)

网站优化 • 优采云 发表了文章 • 0 个评论 • 54 次浏览 • 2022-01-31 13:03

php抓取网页所有图片【php抓取网页所有图片】视频教程_php入门教程_php技术交流_51cto学院|在线学习教程你可以参考下这个教程

一个产品经理怎么会问这种问题呢,你要做的是在a产品上搭配好b产品,能实现a产品的需求就可以了,产品设计的目的是解决需求,将需求用a产品表达出来,而不是傻傻的搭配b产品,因为a产品不需要实现b产品的需求,b产品就不再是a产品了。举个实际例子,当一个刚需的a产品遇到一个稍高的需求,如a产品完成功能b产品完成图片b产品再完成功能就可以了,在这个功能不变的情况下,b产品的性能必须优于a产品不能影响客户,如b产品不可能带着一个imageview去连接a或b的数据库存取效率等等,所以搭配好哪个的性能更优先用哪个!另外php不太可能搭配任何其他语言,如果你的需求在别的语言可以完成,搭配一个什么语言都可以完成的。

原网页还是按照之前的来爬就好,只要能拿到该网页的全部图片,效果都是一样。

你这种需求,完全可以用c++去搞,用python已经大大的降低难度了,不知道是否接触过。python有个pil库,pil(largescaleimageprocessinglibrary)作为一款大规模图像处理库, 查看全部

php抓取网页所有图片(视频教程_php技术交流_51cto学院|在线学习教程)

php抓取网页所有图片【php抓取网页所有图片】视频教程_php入门教程_php技术交流_51cto学院|在线学习教程你可以参考下这个教程

一个产品经理怎么会问这种问题呢,你要做的是在a产品上搭配好b产品,能实现a产品的需求就可以了,产品设计的目的是解决需求,将需求用a产品表达出来,而不是傻傻的搭配b产品,因为a产品不需要实现b产品的需求,b产品就不再是a产品了。举个实际例子,当一个刚需的a产品遇到一个稍高的需求,如a产品完成功能b产品完成图片b产品再完成功能就可以了,在这个功能不变的情况下,b产品的性能必须优于a产品不能影响客户,如b产品不可能带着一个imageview去连接a或b的数据库存取效率等等,所以搭配好哪个的性能更优先用哪个!另外php不太可能搭配任何其他语言,如果你的需求在别的语言可以完成,搭配一个什么语言都可以完成的。

原网页还是按照之前的来爬就好,只要能拿到该网页的全部图片,效果都是一样。

你这种需求,完全可以用c++去搞,用python已经大大的降低难度了,不知道是否接触过。python有个pil库,pil(largescaleimageprocessinglibrary)作为一款大规模图像处理库,

php抓取网页所有图片(云服务器架构优化设计及程序性能调优》php抓取网页所有图片功能介绍)

网站优化 • 优采云 发表了文章 • 0 个评论 • 69 次浏览 • 2022-01-24 16:07

php抓取网页所有图片功能介绍百度云分享站点网页是一个很有意思的的东西,各种广告,各种弹窗,不是很精致,但是非常适合做一些抓取任务。但是这个软件不可以用于视频任务中,图片可以。这个软件只有16.13m,轻量级,速度很快,可以切换成浏览器显示,简直是完美的抓取网页方案。软件详细教程:这个软件挺方便的,特别是用安卓手机登录的同学,很多地方都可以看到内容。以上均免费,无广告。

fiddler.conf文件配置。

telegram:superviewer,findspeedfree(dark)modeandpornershadowdarkenabledandfree(transparent)onfibersitisrecommendedtoconfigureuseifyouareinthewhitecycles。

我是来求助的,抓取网站图片,我想到的就是迅雷,大家不妨也试试。

《云服务器架构优化设计及程序性能调优》,这个是我的博客文章,希望能帮到你。

bt客户端的rip功能

安卓有云推,

利用迅雷可以看到离线下载的内容,不知道算不算黑科技。

电脑上没有用过好的软件但是你可以用小火泡来抓,以我的经验我只能实现看图片,在微博上好多视频被封被举报下架,每次都是搞得焦头烂额只能用迅雷

因为有小猪, 查看全部

php抓取网页所有图片(云服务器架构优化设计及程序性能调优》php抓取网页所有图片功能介绍)

php抓取网页所有图片功能介绍百度云分享站点网页是一个很有意思的的东西,各种广告,各种弹窗,不是很精致,但是非常适合做一些抓取任务。但是这个软件不可以用于视频任务中,图片可以。这个软件只有16.13m,轻量级,速度很快,可以切换成浏览器显示,简直是完美的抓取网页方案。软件详细教程:这个软件挺方便的,特别是用安卓手机登录的同学,很多地方都可以看到内容。以上均免费,无广告。

fiddler.conf文件配置。

telegram:superviewer,findspeedfree(dark)modeandpornershadowdarkenabledandfree(transparent)onfibersitisrecommendedtoconfigureuseifyouareinthewhitecycles。

我是来求助的,抓取网站图片,我想到的就是迅雷,大家不妨也试试。

《云服务器架构优化设计及程序性能调优》,这个是我的博客文章,希望能帮到你。

bt客户端的rip功能

安卓有云推,

利用迅雷可以看到离线下载的内容,不知道算不算黑科技。

电脑上没有用过好的软件但是你可以用小火泡来抓,以我的经验我只能实现看图片,在微博上好多视频被封被举报下架,每次都是搞得焦头烂额只能用迅雷

因为有小猪,

php抓取网页所有图片(爬取快手用户上传的图片是怎么做的??)

网站优化 • 优采云 发表了文章 • 0 个评论 • 64 次浏览 • 2022-01-11 20:05

php抓取网页所有图片地址,

python有用到urllib,xpathlib和pil库,

python中有urllib.request和xpath库

正则是用来匹配文件或者网址的,需要定位到自己实际要寻找的东西,没用过正则,推荐一个叫urllib的库,输入网址,就能得到请求发送的包装后的正则表达式,然后根据正则表达式去匹配你需要得到的信息。

python是调用系统api接口来实现业务功能,例如相册这个事例,利用程序爬取快手所有用户用过的图片,只是爬取快手用户上传的图片,

正则的内容来源??你是指后缀名吗?我没看错的话,

python中有urllib,xpath等等,

爬取快手用户上传的图片,这只是我的理解,个人感觉用一些方法还是能解决的,比如用python来抓取表情包什么的,urllib库的request库可以提供很多python方面的函数,不过我看完题主的题目,

用selenium打开当前网页

python中可以自己写,不需要写爬虫模块,

如果是单纯要爬取快手用户上传的图片的话,感觉用正则表达式更快吧。 查看全部

php抓取网页所有图片(爬取快手用户上传的图片是怎么做的??)

php抓取网页所有图片地址,

python有用到urllib,xpathlib和pil库,

python中有urllib.request和xpath库

正则是用来匹配文件或者网址的,需要定位到自己实际要寻找的东西,没用过正则,推荐一个叫urllib的库,输入网址,就能得到请求发送的包装后的正则表达式,然后根据正则表达式去匹配你需要得到的信息。

python是调用系统api接口来实现业务功能,例如相册这个事例,利用程序爬取快手所有用户用过的图片,只是爬取快手用户上传的图片,

正则的内容来源??你是指后缀名吗?我没看错的话,

python中有urllib,xpath等等,

爬取快手用户上传的图片,这只是我的理解,个人感觉用一些方法还是能解决的,比如用python来抓取表情包什么的,urllib库的request库可以提供很多python方面的函数,不过我看完题主的题目,

用selenium打开当前网页

python中可以自己写,不需要写爬虫模块,

如果是单纯要爬取快手用户上传的图片的话,感觉用正则表达式更快吧。

php抓取网页所有图片(php抓取网页所有图片的代码,用php吧,php图片处理的话用flash比较方便)

网站优化 • 优采云 发表了文章 • 0 个评论 • 66 次浏览 • 2021-12-25 01:02

php抓取网页所有图片的代码,用php吧,

php图片处理的话用flash比较方便,可以尝试看看springmvc加上easyimage,本地数据库就用mysql,一般都用vendor整合,这样图片交互最方便。实际应用效果到要看具体项目内容了。

php最最基本的就是图片缓存gzip压缩网页php5.3版本以上就自带了http请求响应报文处理php5.0还没有

基本的基本php的http协议基本的负载均衡你不需要什么高级的php框架了。php容易入门。

首先http协议基本上你都要懂,如果你不懂http请求的数据格式也就难以完成图片的抓取工作。php比较入门的方法推荐先学习flash。ssh就不用学了,没有对比就没有伤害。

基本的php就行了,

看完这个吧html5tutorial25讲得好好看哟

php好入门,上手快,而且部署容易!但是其中比较难的是最后的模板引擎!图片就是靠http请求获取的!我用的php安装包以gzip格式的!题主可以试试看,前提是你得懂http协议。

嗯,如果你要抓图片,请先把图片转存为canvas图片或者你也可以使用quicktime加速,p2p都可以。 查看全部

php抓取网页所有图片(php抓取网页所有图片的代码,用php吧,php图片处理的话用flash比较方便)

php抓取网页所有图片的代码,用php吧,

php图片处理的话用flash比较方便,可以尝试看看springmvc加上easyimage,本地数据库就用mysql,一般都用vendor整合,这样图片交互最方便。实际应用效果到要看具体项目内容了。

php最最基本的就是图片缓存gzip压缩网页php5.3版本以上就自带了http请求响应报文处理php5.0还没有

基本的基本php的http协议基本的负载均衡你不需要什么高级的php框架了。php容易入门。

首先http协议基本上你都要懂,如果你不懂http请求的数据格式也就难以完成图片的抓取工作。php比较入门的方法推荐先学习flash。ssh就不用学了,没有对比就没有伤害。

基本的php就行了,

看完这个吧html5tutorial25讲得好好看哟

php好入门,上手快,而且部署容易!但是其中比较难的是最后的模板引擎!图片就是靠http请求获取的!我用的php安装包以gzip格式的!题主可以试试看,前提是你得懂http协议。

嗯,如果你要抓图片,请先把图片转存为canvas图片或者你也可以使用quicktime加速,p2p都可以。

php抓取网页所有图片(Fatkun图片批量下载插件一个智能下载器(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 80 次浏览 • 2021-12-24 07:13

我们在浏览网页时,经常会发现网页上有很多我们喜欢的图片,想要保存下载。通常的方法是在图片上右击,将图片一张一张保存,费时费力。. 还有一些网站被保护了,即使保存了,也是很小的图片,不能满足我们的需求。可以批量下载网页中的原图吗?答案是肯定的。

首先,提取网页图片的第一个想法可以使用浏览器扩展,即浏览器插件。俗话说,没有插件的浏览器没有灵魂。这里有几个批量下载网页图片的扩展,供大家参考。

Fatkun图片批量下载插件

这是一个老品牌的图片批量下载插件。它已经发布多年。经过几次更新,它变得越来越强大。一键快速提取网页图片,支持网站的大部分大图分析,直接提取原图。.

我们在浏览网页时,网站为了提高响应速度,经常会显示分辨率比较小的图片。当用户点击图片的详细信息时,会进入另一个页面,然后会显示分辨率更高的图片。这样,网站也可以增加自己的流量,但是对于我们用户来说,为了获得更大分辨率的图片,还需要多走几步,对于优采云来说实在是不适合。Fatkun图片批量下载比较神奇的地方之一就是可以直接获取高分辨率大图。通过与作者交流,通过适配不同的网站来实现,也就是所谓的“智能脚本”。

另外值得一提的是,强大的过滤功能可以对提取的图片进行多种条件过滤,支持当前页面和所有打开标签的图片提取。

2. AIX 智能下载器

AIX Smart Downloader 可以一键快速提取当前网页图片。该插件集成了多种提取技术,可以提取出现在复杂页面环境中的图片。主要功能包括:

3. 图片助理 (IA)

图片助手(IA)可以快速提取网页图片并批量下载。整个页面的图片在标签页中以缩略图的形式显示,缩略图可以添加过滤条件。这也是一款老牌图片批量下载插件。

其次,除了上面的扩展,还有一个在线图片提取网站供大家参考

4.提取图像

打开网站后,在对话框中输入要提取的图片地址。解压后可以简单的对图片进行过滤,去掉不想下载的图片,然后点击“下载选中”即可。

总结:

以上方法均可批量下载网页图片

按方便:Fatkun = AIX> 图片助手(IA)> 在线提取

按功能:AIX>fatkun>图片助手(IA)>在线提取

按智能:Fatkun = AIX> 图片助手(IA)> 在线提取

您可以根据需要选择最合适的工具来使用。 查看全部

php抓取网页所有图片(Fatkun图片批量下载插件一个智能下载器(组图))

我们在浏览网页时,经常会发现网页上有很多我们喜欢的图片,想要保存下载。通常的方法是在图片上右击,将图片一张一张保存,费时费力。. 还有一些网站被保护了,即使保存了,也是很小的图片,不能满足我们的需求。可以批量下载网页中的原图吗?答案是肯定的。

首先,提取网页图片的第一个想法可以使用浏览器扩展,即浏览器插件。俗话说,没有插件的浏览器没有灵魂。这里有几个批量下载网页图片的扩展,供大家参考。

Fatkun图片批量下载插件

这是一个老品牌的图片批量下载插件。它已经发布多年。经过几次更新,它变得越来越强大。一键快速提取网页图片,支持网站的大部分大图分析,直接提取原图。.

我们在浏览网页时,网站为了提高响应速度,经常会显示分辨率比较小的图片。当用户点击图片的详细信息时,会进入另一个页面,然后会显示分辨率更高的图片。这样,网站也可以增加自己的流量,但是对于我们用户来说,为了获得更大分辨率的图片,还需要多走几步,对于优采云来说实在是不适合。Fatkun图片批量下载比较神奇的地方之一就是可以直接获取高分辨率大图。通过与作者交流,通过适配不同的网站来实现,也就是所谓的“智能脚本”。

另外值得一提的是,强大的过滤功能可以对提取的图片进行多种条件过滤,支持当前页面和所有打开标签的图片提取。

2. AIX 智能下载器

AIX Smart Downloader 可以一键快速提取当前网页图片。该插件集成了多种提取技术,可以提取出现在复杂页面环境中的图片。主要功能包括:

3. 图片助理 (IA)

图片助手(IA)可以快速提取网页图片并批量下载。整个页面的图片在标签页中以缩略图的形式显示,缩略图可以添加过滤条件。这也是一款老牌图片批量下载插件。

其次,除了上面的扩展,还有一个在线图片提取网站供大家参考

4.提取图像

打开网站后,在对话框中输入要提取的图片地址。解压后可以简单的对图片进行过滤,去掉不想下载的图片,然后点击“下载选中”即可。

总结:

以上方法均可批量下载网页图片

按方便:Fatkun = AIX> 图片助手(IA)> 在线提取

按功能:AIX>fatkun>图片助手(IA)>在线提取

按智能:Fatkun = AIX> 图片助手(IA)> 在线提取

您可以根据需要选择最合适的工具来使用。

php抓取网页所有图片(PHP、java、javascript、python,我在这里简单的实现一下)

网站优化 • 优采云 发表了文章 • 0 个评论 • 51 次浏览 • 2021-12-22 20:09

除了C/C++,我还接触过很多流行的语言,PHP、java、javascript、python,其中python可以说是操作最方便、缺点最少的语言。

前几天想写个爬虫,但是和朋友商量后,决定过几天再一起写。爬虫的一个重要部分是抓取页面中的链接。我将在这里简单地实现它。

首先,我们需要使用一个开源模块,requests。这不是python自带的模块,需要从网上下载解压安装:

$ curl -OL https://github.com/kennethreitz/requests/zipball/master

$ python setup.py install

Windows用户直接点击下载。解压后在本地使用命令python setup.py install进行安装。

我也在慢慢翻译这个模块的文档,翻译完后传给大家(英文版先发在附件里)。正如其描述中所述,为人类而设计,为人类而设计。使用起来很方便,自己看文档。最简单的 requests.get() 是发送一个 get 请求。

代码显示如下:

# coding:utf-8

import re

import requests

# 获取网页内容 r = requests.get('')data = r.text

# 使用常规规则查找所有连接 link_list =re.findall(r"(? 查看全部

php抓取网页所有图片(PHP、java、javascript、python,我在这里简单的实现一下)

除了C/C++,我还接触过很多流行的语言,PHP、java、javascript、python,其中python可以说是操作最方便、缺点最少的语言。

前几天想写个爬虫,但是和朋友商量后,决定过几天再一起写。爬虫的一个重要部分是抓取页面中的链接。我将在这里简单地实现它。

首先,我们需要使用一个开源模块,requests。这不是python自带的模块,需要从网上下载解压安装:

$ curl -OL https://github.com/kennethreitz/requests/zipball/master

$ python setup.py install

Windows用户直接点击下载。解压后在本地使用命令python setup.py install进行安装。

我也在慢慢翻译这个模块的文档,翻译完后传给大家(英文版先发在附件里)。正如其描述中所述,为人类而设计,为人类而设计。使用起来很方便,自己看文档。最简单的 requests.get() 是发送一个 get 请求。

代码显示如下:

# coding:utf-8

import re

import requests

# 获取网页内容 r = requests.get('')data = r.text

# 使用常规规则查找所有连接 link_list =re.findall(r"(?

php抓取网页所有图片( Excel教程Excel函数Excel透视表Excel电子表格Excel实用技巧Excel2010-12-10 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 53 次浏览 • 2021-12-16 16:09

Excel教程Excel函数Excel透视表Excel电子表格Excel实用技巧Excel2010-12-10

)

Python3抓取网络图片

时间:2021-12-10

本文章为大家介绍使用Python3采集网络图片,包括Python3采集网络图片示例、应用技巧、基础知识点总结、注意事项。有一定的参考价值,有需要的朋友可以参考。

一、普通爬取方法

没有头部信息,网站没有任何可用的防爬措施。喜欢

#-*- encoding:utf-8 -*-

"""

@desc 抓取普通网络图片

@author Sanplit

"""

import os

import re

import urllib.request

input_url = input('Please input your url: ')

# input_url = 'http://pic.ziweidan.com'

#根据给定的网址来获取网页详细,得到网页的源码

def getHtml(url):

html = urllib.request.urlopen(input_url).read().decode('utf8')

return html

#目录是否存在,不存在则创建

def createDir(path):

if not os.path.exists(path):

os.makedirs(path)

else:

if os.path.isfile(path):

os.mkdir(path)

#保存图片

def saveImg(imgList, path = 'img2\\'):

createDir(path)

imgIndex = 1

for imgUrl in imgList:

#打开imgList中保存的图片网址,并下载图片保存在本地,format格式化字符

urllib.request.urlretrieve(imgUrl,'{}{}.jpg'.format(path,imgIndex))

imgIndex += 1

print('------ over -------')

html = getHtml(input_url)

#匹配图片标签

reg = r'src="(.+?\.jpg|png|gif)"'

imgre = re.compile(reg, re.I)

imglist = re.findall(imgre, html)