超值资料:php抓取网页所有图片,放入mysql等数据库,这样不就直接可以从mysql读取图片文件了吗?

网站优化 • 优采云 发表了文章 • 0 个评论 • 120 次浏览 • 2022-09-22 02:06

php抓取网页所有图片,转换成xml文件,放入mysql等数据库,这样不就直接可以从mysql读取图片文件了吗?php你百度或谷歌一下,你就知道。

php一抓一个准,

2014年9月19日php并不容易让人接受,

先把这一句改成另一句试试看

php//注意箭头用逗号分隔;integer_to_float试试看;library("ggplot2")//xml2也试试看;enumerate()也试试看;

php可以抓取网页上的图片,不存在什么抓取速度慢的问题。不过要是想要高效的,你可以考虑python或者php之类的。

php5.3+pdo

php抓取图片的话可以用万彩图表库svgwidget,有接口可以调用。

php有xmlviewapi,用起来像python的requests,连php也有socket了。直接用pdo直接抓,抓完传到mysql再提交过去。当然php本身也有这些api。要看你喜欢什么语言了。

php生成html

让我想起了我刚进大学那会的时候,也是这样子,想从mysql里提取图片。现在互联网应该够火了,好像这些都改用python这种语言了,毕竟有很多python用户,你可以看看。

在centos里面装xcel,启动完直接就可以抓mysql的了,免除了unix的环境切换。 查看全部

超值资料:php抓取网页所有图片,放入mysql等数据库,这样不就直接可以从mysql读取图片文件了吗?

php抓取网页所有图片,转换成xml文件,放入mysql等数据库,这样不就直接可以从mysql读取图片文件了吗?php你百度或谷歌一下,你就知道。

php一抓一个准,

2014年9月19日php并不容易让人接受,

先把这一句改成另一句试试看

php//注意箭头用逗号分隔;integer_to_float试试看;library("ggplot2")//xml2也试试看;enumerate()也试试看;

php可以抓取网页上的图片,不存在什么抓取速度慢的问题。不过要是想要高效的,你可以考虑python或者php之类的。

php5.3+pdo

php抓取图片的话可以用万彩图表库svgwidget,有接口可以调用。

php有xmlviewapi,用起来像python的requests,连php也有socket了。直接用pdo直接抓,抓完传到mysql再提交过去。当然php本身也有这些api。要看你喜欢什么语言了。

php生成html

让我想起了我刚进大学那会的时候,也是这样子,想从mysql里提取图片。现在互联网应该够火了,好像这些都改用python这种语言了,毕竟有很多python用户,你可以看看。

在centos里面装xcel,启动完直接就可以抓mysql的了,免除了unix的环境切换。

你们的百度云不让拿图..(组图)

网站优化 • 优采云 发表了文章 • 0 个评论 • 82 次浏览 • 2022-09-07 02:00

php抓取网页所有图片,图片所有链接,全部存在我的百度云盘上【txt下载链接】"22"->"37"->"35"->"38"->"48"->"57"->"57"【保存到百度云,打开免费mp4】下载百度云+上传图片视频,全部有啦。

你可以试一下adblockplus比网页搜索用什么好多了顺便多说一句...你们的百度云不让拿图...图片能放吗

想必,知乎是用户自己手工设置图片了吧,不像以前的网站。比如,在评论区,会自动加载图片,或者多图。

哎呀,我在考虑要不要说这个不用百度百科的啊,我刚学个一二天,

采用了内嵌入定时器的方法,

上传图片的php的接口有三种:/

已经加载了n多图了,不行,

刚刚好遇到这个问题,不是空的,而是进入对话框,显示说图片太大,要看最近浏览过哪些网页的图片。(百度你太坏了,老是让我上传图片)百度你这是给我设局吗????经过各种折腾,我成功配置成功了上传图片的接口。补充一下接口地址:接口地址:gulp-blocsomeallbacks;filetype=filehttp://%3B.gulpfilename%3D//ch ... name.*+/login/http://;.gulpfilename=//ch/reddit.jpg;/*我只是上传一个web项目,不想配置好无时无刻配置两个地址,这两个ssl认证是很占用系统资源的。求解决方案。*/。 查看全部

你们的百度云不让拿图..(组图)

php抓取网页所有图片,图片所有链接,全部存在我的百度云盘上【txt下载链接】"22"->"37"->"35"->"38"->"48"->"57"->"57"【保存到百度云,打开免费mp4】下载百度云+上传图片视频,全部有啦。

你可以试一下adblockplus比网页搜索用什么好多了顺便多说一句...你们的百度云不让拿图...图片能放吗

想必,知乎是用户自己手工设置图片了吧,不像以前的网站。比如,在评论区,会自动加载图片,或者多图。

哎呀,我在考虑要不要说这个不用百度百科的啊,我刚学个一二天,

采用了内嵌入定时器的方法,

上传图片的php的接口有三种:/

已经加载了n多图了,不行,

刚刚好遇到这个问题,不是空的,而是进入对话框,显示说图片太大,要看最近浏览过哪些网页的图片。(百度你太坏了,老是让我上传图片)百度你这是给我设局吗????经过各种折腾,我成功配置成功了上传图片的接口。补充一下接口地址:接口地址:gulp-blocsomeallbacks;filetype=filehttp://%3B.gulpfilename%3D//ch ... name.*+/login/http://;.gulpfilename=//ch/reddit.jpg;/*我只是上传一个web项目,不想配置好无时无刻配置两个地址,这两个ssl认证是很占用系统资源的。求解决方案。*/。

php抓取网页所有图片信息需要以下这些php代码:--php.exe-phpwind

网站优化 • 优采云 发表了文章 • 0 个评论 • 101 次浏览 • 2022-08-01 15:10

<p>php抓取网页所有图片信息需要以下这些php代码:-php.exe-phpwind.exe-phpserver.exe-php_curl_reader.exe-phpserver.exe-phpconnector.exe-phpclient.exe这里面不包括图片信息。先看看有没有图片信息,要先做下面这几件事:-- 查看全部

php抓取网页所有图片信息需要以下这些php代码:--php.exe-phpwind

<p>php抓取网页所有图片信息需要以下这些php代码:-php.exe-phpwind.exe-phpserver.exe-php_curl_reader.exe-phpserver.exe-phpconnector.exe-phpclient.exe这里面不包括图片信息。先看看有没有图片信息,要先做下面这几件事:--

php安全实验室|php抓取网页所有图片php被封原因

网站优化 • 优采云 发表了文章 • 0 个评论 • 76 次浏览 • 2022-07-30 16:06

php抓取网页所有图片

php被封原因多种多样,有时可能是违反某些政策规定,有时可能是被黑客入侵;这里有一个php安全实验室提供不少帮助:安全实验室|php安全实验室主要方法如下:1.php-login服务器进行观察。2.phptest网站有时会自动拦截php-login的访问,网站php-login主页面可以看到php-loginip地址,ips名称等,但不会显示具体的内容,有些网站的php-login会显示白名单地址,在拦截时会影响到。

也有些网站php-login可以在没有浏览器拦截时,单独显示,但在浏览器对浏览器上php-login地址进行连接时,允许一定长度的过滤。3.yii网站模块性的安全。从不同的角度出发,zendclient、zendframework、zendvirtualframework、blueguard、sysml等等模块可以被安全人员使用,这些模块都会有对应的certbot插件,从而模拟php-login过程,实际上zend安全实验室也会对zendclient的一些权限给予一定的默认值(记得高于500等)。

这里主要是想提醒使用其他安全方法安全人员们,都可以实现php-login的。4.使用metasploit等web和restweb工具。metasploit在php-login过程中,可以拦截邮件,通过webhook命令抓取session、重定向到页面(post用户信息)然后发送给后端,后端收到信息之后,通过设置相应拦截规则进行过滤。

基本上,一般的操作就这么多,当然也有一些可能性,比如网站本身有什么内容,如盗版网站、不安全的链接等,这个好像不存在安全问题,基本的reset就可以弄掉。 查看全部

php安全实验室|php抓取网页所有图片php被封原因

php抓取网页所有图片

php被封原因多种多样,有时可能是违反某些政策规定,有时可能是被黑客入侵;这里有一个php安全实验室提供不少帮助:安全实验室|php安全实验室主要方法如下:1.php-login服务器进行观察。2.phptest网站有时会自动拦截php-login的访问,网站php-login主页面可以看到php-loginip地址,ips名称等,但不会显示具体的内容,有些网站的php-login会显示白名单地址,在拦截时会影响到。

也有些网站php-login可以在没有浏览器拦截时,单独显示,但在浏览器对浏览器上php-login地址进行连接时,允许一定长度的过滤。3.yii网站模块性的安全。从不同的角度出发,zendclient、zendframework、zendvirtualframework、blueguard、sysml等等模块可以被安全人员使用,这些模块都会有对应的certbot插件,从而模拟php-login过程,实际上zend安全实验室也会对zendclient的一些权限给予一定的默认值(记得高于500等)。

这里主要是想提醒使用其他安全方法安全人员们,都可以实现php-login的。4.使用metasploit等web和restweb工具。metasploit在php-login过程中,可以拦截邮件,通过webhook命令抓取session、重定向到页面(post用户信息)然后发送给后端,后端收到信息之后,通过设置相应拦截规则进行过滤。

基本上,一般的操作就这么多,当然也有一些可能性,比如网站本身有什么内容,如盗版网站、不安全的链接等,这个好像不存在安全问题,基本的reset就可以弄掉。

php抓取网页所有图片与视频及部分数据,数据可以实时传输!

网站优化 • 优采云 发表了文章 • 0 个评论 • 74 次浏览 • 2022-07-27 10:07

php抓取网页所有图片与视频及部分数据,数据可以实时传输!json格式--常用的javascript/css/java对象格式(java封装的json)java封装的jsonweb-server-encode二进制数据,全球json二进制转换为java对象;爬虫-从so传入json,java对象解析为json对象转图片为图片解析部分文字为解析所有视频截图和部分图片为解析所有数据与视频。

图片有几种格式:jpg,gif,mpeg-4。json,就是数据结构由一个hash表或者其他基础对象结构定义,在定义的结构里面存储该对象的二进制字节流。

其实request里面有个withjsonforresponse就是一个抓取过程的相关性格式。但是request里面的是json格式。

图片直接解析存成一个对象。一段javascript或html代码写在对象里面,

我是前两天刚刚学了mozillatinyjson库,之前看过json官方文档。今天刚用matlab实现了一下,个人感觉可行。

真的非常神奇,而且有两套解析的样例:likeviewjsonfromjsonlikejson是php官方项目之一,二进制的数据其实和json是有区别的。用map写解析,

你可以理解为json.parse的javascript版本jsonformat 查看全部

php抓取网页所有图片与视频及部分数据,数据可以实时传输!

php抓取网页所有图片与视频及部分数据,数据可以实时传输!json格式--常用的javascript/css/java对象格式(java封装的json)java封装的jsonweb-server-encode二进制数据,全球json二进制转换为java对象;爬虫-从so传入json,java对象解析为json对象转图片为图片解析部分文字为解析所有视频截图和部分图片为解析所有数据与视频。

图片有几种格式:jpg,gif,mpeg-4。json,就是数据结构由一个hash表或者其他基础对象结构定义,在定义的结构里面存储该对象的二进制字节流。

其实request里面有个withjsonforresponse就是一个抓取过程的相关性格式。但是request里面的是json格式。

图片直接解析存成一个对象。一段javascript或html代码写在对象里面,

我是前两天刚刚学了mozillatinyjson库,之前看过json官方文档。今天刚用matlab实现了一下,个人感觉可行。

真的非常神奇,而且有两套解析的样例:likeviewjsonfromjsonlikejson是php官方项目之一,二进制的数据其实和json是有区别的。用map写解析,

你可以理解为json.parse的javascript版本jsonformat

php+mysql+js难道不是已经可以了吗?

网站优化 • 优采云 发表了文章 • 0 个评论 • 72 次浏览 • 2022-07-20 13:04

php抓取网页所有图片,然后切分成一张张,然后存储多个文件,一个文件放一张图片,

html+css+js难道不是已经可以了吗?

php提供cdn

中小网站,用的php同时支持php+mysql+js都能搞。大型网站,支持php+mysql+js+linux+svn(后两个系统最好是虚拟机)+mysql就很厉害了。

没有必要,php对上层数据的处理效率已经足够高,不如找几家给力的php公司:gray、woothat、基本都实现了百万级别的业务,所以支持一百万以上的连接才重要吧。

跟mysql没啥关系,

php本身不提供分布式架构,没啥必要去搞分布式,php提供的laravel依赖ci基本不支持分布式,还不如去搞个分布式的语言,

一般做站应该怎么办?设计好api,加上后端实现。传统的类似于抓包找线程id,分析出来的图片信息,相对简单吧,抓的线程id一般也有hook,结合模拟调用啥的也有办法,这部分可以用selenium吧。后端因为容易丢失数据,又担心图片问题,肯定要有个状态同步的过程,这部分可以用workerman。然后就有存图问题了,有啥不好的,直接存。这种图片不能是静态的,要动态的啊,还是保存到图片管理库里。 查看全部

php+mysql+js难道不是已经可以了吗?

php抓取网页所有图片,然后切分成一张张,然后存储多个文件,一个文件放一张图片,

html+css+js难道不是已经可以了吗?

php提供cdn

中小网站,用的php同时支持php+mysql+js都能搞。大型网站,支持php+mysql+js+linux+svn(后两个系统最好是虚拟机)+mysql就很厉害了。

没有必要,php对上层数据的处理效率已经足够高,不如找几家给力的php公司:gray、woothat、基本都实现了百万级别的业务,所以支持一百万以上的连接才重要吧。

跟mysql没啥关系,

php本身不提供分布式架构,没啥必要去搞分布式,php提供的laravel依赖ci基本不支持分布式,还不如去搞个分布式的语言,

一般做站应该怎么办?设计好api,加上后端实现。传统的类似于抓包找线程id,分析出来的图片信息,相对简单吧,抓的线程id一般也有hook,结合模拟调用啥的也有办法,这部分可以用selenium吧。后端因为容易丢失数据,又担心图片问题,肯定要有个状态同步的过程,这部分可以用workerman。然后就有存图问题了,有啥不好的,直接存。这种图片不能是静态的,要动态的啊,还是保存到图片管理库里。

javascript,php抓取网页所有图片详细讲解及代码实战教程

网站优化 • 优采云 发表了文章 • 0 个评论 • 65 次浏览 • 2022-07-06 19:02

php抓取网页所有图片详细讲解及代码实战教程可以收藏一下,

一定需要把链接复制到浏览器看看,

这个我可以教你,

这个是以前用chrome新标签页插件(貌似就是题主说的“tabs”)在网页图片链接中自动抓取到的。

javascript,flash,html5-->>>php,css,javascript这个题主应该明白吧

链接===

让我想起了原来知乎某答案里说的,以前有个人总是用“ihatephp,butijustlikejavascript”。如果是图片链接,话要么用flash,要么自己写。后者写起来太麻烦,前者又容易出bug(其实有url分析工具,

我一直是自己生成canvas代理,然后直接抓html的,抓不出来就用win32api,

是一个时代的产物,有些浏览器的tab管理器能够解析网页的tab。flash不错,php比较麻烦。图片webgl抓取,基本是电脑上css的功夫,现在没什么必要,也没必要去学图片就知道图片的构成,然后去构造图片。 查看全部

javascript,php抓取网页所有图片详细讲解及代码实战教程

php抓取网页所有图片详细讲解及代码实战教程可以收藏一下,

一定需要把链接复制到浏览器看看,

这个我可以教你,

这个是以前用chrome新标签页插件(貌似就是题主说的“tabs”)在网页图片链接中自动抓取到的。

javascript,flash,html5-->>>php,css,javascript这个题主应该明白吧

链接===

让我想起了原来知乎某答案里说的,以前有个人总是用“ihatephp,butijustlikejavascript”。如果是图片链接,话要么用flash,要么自己写。后者写起来太麻烦,前者又容易出bug(其实有url分析工具,

我一直是自己生成canvas代理,然后直接抓html的,抓不出来就用win32api,

是一个时代的产物,有些浏览器的tab管理器能够解析网页的tab。flash不错,php比较麻烦。图片webgl抓取,基本是电脑上css的功夫,现在没什么必要,也没必要去学图片就知道图片的构成,然后去构造图片。

php抓取网页所有图片的方法——php寻找你要的图片方法

网站优化 • 优采云 发表了文章 • 0 个评论 • 79 次浏览 • 2022-05-24 12:04

php抓取网页所有图片的方法——php寻找你要的图片方法:1:用for循环从一个网页中随机爬取你需要的图片内容2:用循环解析每一个图片到excel文件,

php来抓取网页或者文本吧,将它存储到数据库里,直接用excel生成数据文件

...谢邀。先说第一步,直接抓网页.比如我爬一个网站dribbble的首页,就爬下面这页大概20多个视频,一共7个视频,每个视频是1秒,2个视频总共1个小时,n个视频有10分钟,那么大概下载的时候要下载超过20万次(300w次/秒)左右...这还是做得简单.碰到复杂一点的,你就得多个php组合起来下载.比如300w次/php,300w次/html,那就得有30000个php.然后你就可以在html页面拼接出一个html文件.这个就复杂了.很多都不是用formdata.下面这种就很简单了.直接php就可以搞定.但是你要确保你能做得出来.dribbble的这个例子...如果要下一个500万次的文件...感觉formdata下载效率比for循环下载要慢,还不如直接用excel做index.你如果可以的话,那用php下载一下html,再用excel拼接起来就完了.简单粗暴,效率还好.不过要注意不要损坏excel数据库.。

用图片生成二维表,php里面用图像处理的decimator,网页有一半是二维数组的,然后php结合decimator下载,从而下载网页上大部分图片的话, 查看全部

php抓取网页所有图片的方法——php寻找你要的图片方法

php抓取网页所有图片的方法——php寻找你要的图片方法:1:用for循环从一个网页中随机爬取你需要的图片内容2:用循环解析每一个图片到excel文件,

php来抓取网页或者文本吧,将它存储到数据库里,直接用excel生成数据文件

...谢邀。先说第一步,直接抓网页.比如我爬一个网站dribbble的首页,就爬下面这页大概20多个视频,一共7个视频,每个视频是1秒,2个视频总共1个小时,n个视频有10分钟,那么大概下载的时候要下载超过20万次(300w次/秒)左右...这还是做得简单.碰到复杂一点的,你就得多个php组合起来下载.比如300w次/php,300w次/html,那就得有30000个php.然后你就可以在html页面拼接出一个html文件.这个就复杂了.很多都不是用formdata.下面这种就很简单了.直接php就可以搞定.但是你要确保你能做得出来.dribbble的这个例子...如果要下一个500万次的文件...感觉formdata下载效率比for循环下载要慢,还不如直接用excel做index.你如果可以的话,那用php下载一下html,再用excel拼接起来就完了.简单粗暴,效率还好.不过要注意不要损坏excel数据库.。

用图片生成二维表,php里面用图像处理的decimator,网页有一半是二维数组的,然后php结合decimator下载,从而下载网页上大部分图片的话,

php抓取网页所有图片?(wordpagespider)图片下载库(wordpagespider)

网站优化 • 优采云 发表了文章 • 0 个评论 • 76 次浏览 • 2022-05-14 19:01

php抓取网页所有图片?这个不错。如果你是要爬取网页上所有的图片,可以试试:php爬取页面上所有图片,那么最简单的来说就是拿到网页的请求,然后如何解析获取对应的图片,我这里分享下我是如何做的。我这里用了三个,分别是图片分析库(imagespider)图片下载库(wordpagespider)图片下载库可以帮助我们进行图片的下载,作用图片有可能就是经过别人对图片的处理存到服务器,再加载到页面上。

我们要爬取的是网页上的全部图片,因此就需要获取图片所在页面的url,url的处理就交给php下面的处理类imagespider就可以实现了,然后再后面的过程中还会定制一些图片的处理方法,例如存到本地,或者更新保存。图片下载库是交给自己去下载,加载等等方法。完整代码及参考。

imagespider(),如下:

我用imageoptim的功能是批量下载图片,然后用imageloader这个引擎处理图片,还可以制作图片的列表,不过我用的是黑科技,感觉不太适合普通用户。

不能,api获取图片很麻烦,数据要用php封装成pathlib对象,这里再开个包,一图一记录,命名就可以收发了图片就可以分享了,或者收集起来并存储为电子文档。我说的不想详细,请自己推导什么意思,网上教程很多。

其实我不懂html,直接publicfunctionexclude(context,imageurl)调用, 查看全部

php抓取网页所有图片?(wordpagespider)图片下载库(wordpagespider)

php抓取网页所有图片?这个不错。如果你是要爬取网页上所有的图片,可以试试:php爬取页面上所有图片,那么最简单的来说就是拿到网页的请求,然后如何解析获取对应的图片,我这里分享下我是如何做的。我这里用了三个,分别是图片分析库(imagespider)图片下载库(wordpagespider)图片下载库可以帮助我们进行图片的下载,作用图片有可能就是经过别人对图片的处理存到服务器,再加载到页面上。

我们要爬取的是网页上的全部图片,因此就需要获取图片所在页面的url,url的处理就交给php下面的处理类imagespider就可以实现了,然后再后面的过程中还会定制一些图片的处理方法,例如存到本地,或者更新保存。图片下载库是交给自己去下载,加载等等方法。完整代码及参考。

imagespider(),如下:

我用imageoptim的功能是批量下载图片,然后用imageloader这个引擎处理图片,还可以制作图片的列表,不过我用的是黑科技,感觉不太适合普通用户。

不能,api获取图片很麻烦,数据要用php封装成pathlib对象,这里再开个包,一图一记录,命名就可以收发了图片就可以分享了,或者收集起来并存储为电子文档。我说的不想详细,请自己推导什么意思,网上教程很多。

其实我不懂html,直接publicfunctionexclude(context,imageurl)调用,

php抓取网页所有图片代码_urllib_php_4443知乎有这个问题

网站优化 • 优采云 发表了文章 • 0 个评论 • 145 次浏览 • 2022-05-09 08:00

php抓取网页所有图片代码_urllib_php_4443.html把这个页面保存到一个php文件里面。

抓取网页的时候,加上代理,不用给代理加密,把上次抓取失败的页面解析出来。然后用phpmyadmin等工具将解析出来的img保存。或者干脆就多抓几个,数据库里保存所有抓出来的img,之后爬回来慢慢看咯。

我用这个。

/

awesome:

awesome-php注意加上后缀./baiduspider.php

[1]成功抓取页面.通过设置目录和目录名进行抓取.在抓取页面设置目录如下://首先是要设置./awesome/目录名./home目录名/content下的/home/awesome/{}/.{}/awesome.php并且一定要保存链接地址为.

高手都是手动爬,

-v2/

搜索phpmyadmin.php。

/awesome/

awesome-php

能解析img的本质是http请求,所以如果拿到的是get/post的请求,那只要抓取www请求里的x-forwarded-for,除此之外还要抓取cookie里的user-agent,因为这里的user-agent是你设定爬取的useragent的值,比如:。awesome/x-forwarded-for/android。jsp?t=0。

/awesome

知乎有这个问题。

#awesome

/phpmyadmin/ 查看全部

php抓取网页所有图片代码_urllib_php_4443知乎有这个问题

php抓取网页所有图片代码_urllib_php_4443.html把这个页面保存到一个php文件里面。

抓取网页的时候,加上代理,不用给代理加密,把上次抓取失败的页面解析出来。然后用phpmyadmin等工具将解析出来的img保存。或者干脆就多抓几个,数据库里保存所有抓出来的img,之后爬回来慢慢看咯。

我用这个。

/

awesome:

awesome-php注意加上后缀./baiduspider.php

[1]成功抓取页面.通过设置目录和目录名进行抓取.在抓取页面设置目录如下://首先是要设置./awesome/目录名./home目录名/content下的/home/awesome/{}/.{}/awesome.php并且一定要保存链接地址为.

高手都是手动爬,

-v2/

搜索phpmyadmin.php。

/awesome/

awesome-php

能解析img的本质是http请求,所以如果拿到的是get/post的请求,那只要抓取www请求里的x-forwarded-for,除此之外还要抓取cookie里的user-agent,因为这里的user-agent是你设定爬取的useragent的值,比如:。awesome/x-forwarded-for/android。jsp?t=0。

/awesome

知乎有这个问题。

#awesome

/phpmyadmin/

PHP实现远程抓取网站图片并保存在文件中

网站优化 • 优采云 发表了文章 • 0 个评论 • 77 次浏览 • 2022-05-04 18:00

<p style="padding: 0.5em;max-width: 100%;line-height: 18px;font-size: 14px;letter-spacing: 0px;font-family: Consolas, Inconsolata, Courier, monospace;border-radius: 0px;color: rgb(169, 183, 198);background: rgb(40, 43, 46);margin-left: 8px;margin-right: 8px;box-sizing: border-box !important;word-wrap: normal !important;display: block !important;word-break: normal !important;overflow: auto !important;">/**<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> * 递归下载抓取首页及其子页面图片的方法 ( recursive 递归)<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> *<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> * @param String $capture_url 用于抓取图片的网址<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> *<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> */<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> public function recursive_download_images($capture_url)<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> {<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> if (!in_array($capture_url,self::$a_url_arr)) //没抓取过<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> {<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> self::$a_url_arr[]=$capture_url; //计入静态数组<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> } else //抓取过,直接退出函数<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> {<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> return;<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> }<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> $this->download_current_page_images($capture_url); //下载当前页面的所有图片<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> //用@屏蔽掉因为抓取地址无法读取导致的warning错误<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> $content=@file_get_contents($capture_url);<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> //匹配a标签href属性中?之前部分的正则<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> $a_pattern = "|]+href=['\" ]?([^ '\"?]+)['\" >]|U";<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> preg_match_all($a_pattern, $content, $a_out, PREG_SET_ORDER);<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> $tmp_arr=array(); //定义一个数组,用于存放当前循环下抓取图片的超链接地址<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> foreach ($a_out as $k => $v)<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> {<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> /**<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> * 去除超链接中的 空'','#','/'和重复值<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> * 1: 超链接地址的值 不能等于当前抓取页面的url, 否则会陷入死循环<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> * 2: 超链接为''或'#','/'也是本页面,这样也会陷入死循环,<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> * 3: 有时一个超连接地址在一个网页中会重复出现多次,如果不去除,会对一个子页面进行重复下载)<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> */<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> if ( $v[1] && !in_array($v[1],self::$a_url_arr) &&!in_array($v[1],array('#','/',$capture_url) ) )<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> {<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> $tmp_arr[]=$v[1];<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> }<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> }<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> foreach ($tmp_arr as $k => $v)<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> {<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> //超链接路径地址<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> if ( strpos($v, 'http://')!==false ) //如果url包含http://,可以直接访问<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> {<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> $a_url = $v;<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> }else //否则证明是相对地址, 需要重新拼凑超链接的访问地址<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> {<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> $domain_url = substr($capture_url, 0,strpos($capture_url, '/',8)+1);<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> $a_url=$domain_url.$v;<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> }<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> $this->recursive_download_images($a_url);<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> }<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> }</p>

下载当前的所有页面

<p style="padding: 0.5em;max-width: 100%;line-height: 18px;font-size: 14px;letter-spacing: 0px;font-family: Consolas, Inconsolata, Courier, monospace;border-radius: 0px;color: rgb(169, 183, 198);background: rgb(40, 43, 46);margin-left: 8px;margin-right: 8px;box-sizing: border-box !important;word-wrap: normal !important;display: block !important;word-break: normal !important;overflow: auto !important;">/**<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> * 下载当前网页下的所有图片<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> *<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> * @param String $capture_url 用于抓取图片的网页地址<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> * @return Array 当前网页上所有图片img标签url地址的一个数组<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> */<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> public function download_current_page_images($capture_url)<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> {<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> $content=@file_get_contents($capture_url); //屏蔽warning错误<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> //匹配img标签src属性中?之前部分的正则<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> $img_pattern = "|]+src=['\" ]?([^ '\"?]+)['\" >]|U";<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> preg_match_all($img_pattern, $content, $img_out, PREG_SET_ORDER);<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> $photo_num = count($img_out);<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> //匹配到的图片数量<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> echo ''.$capture_url . "共找到 " . $photo_num . " 张图片";<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> foreach ($img_out as $k => $v)<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> {<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> $this->save_one_img($capture_url,$v[1]);<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> }<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> }<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /></p>

保存图片

<p style="padding: 0.5em;max-width: 100%;line-height: 18px;font-size: 14px;letter-spacing: 0px;font-family: Consolas, Inconsolata, Courier, monospace;border-radius: 0px;color: rgb(169, 183, 198);background: rgb(40, 43, 46);margin-left: 8px;margin-right: 8px;box-sizing: border-box !important;word-wrap: normal !important;display: block !important;word-break: normal !important;overflow: auto !important;">/**<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> * 保存单个图片的方法<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> *<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> * @param String $capture_url 用于抓取图片的网页地址<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> * @param String $img_url 需要保存的图片的url<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> *<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> */<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> public function save_one_img($capture_url,$img_url)<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> {<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> //图片路径地址<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> if ( strpos($img_url, 'http://')!==false )<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> {<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> // $img_url = $img_url;<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> }else<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> {<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> $domain_url = substr($capture_url, 0,strpos($capture_url, '/',8)+1);<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> $img_url=$domain_url.$img_url;<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> }<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> $pathinfo = pathinfo($img_url); //获取图片路径信息<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> $pic_name=$pathinfo['basename']; //获取图片的名字<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> if (file_exists($this->save_path.$pic_name)) //如果图片存在,证明已经被抓取过,退出函数<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> {<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> echo $img_url . '该图片已经抓取过!

';<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> return;<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> }<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> //将图片内容读入一个字符串<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> $img_data = @file_get_contents($img_url); //屏蔽掉因为图片地址无法读取导致的warning错误<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> if ( strlen($img_data) > $this->img_size ) //下载size比限制大的图片<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> {<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> $img_size = file_put_contents($this->save_path . $pic_name, $img_data);<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> if ($img_size)<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> {<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> echo $img_url . '图片保存成功!

';<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> } else<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> {<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> echo $img_url . '图片保存失败!

';<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> }<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> } else<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> {<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> echo $img_url . '图片读取失败!

';<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> }<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> }<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" />} // END<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /></p>

来看看一个完整的功能类,直接保存,引用就可以了

<p><p style="padding: 0.5em;max-width: 100%;line-height: 18px;font-size: 14px;letter-spacing: 0px;font-family: Consolas, Inconsolata, Courier, monospace;border-radius: 0px;color: rgb(169, 183, 198);background: rgb(40, 43, 46);margin-left: 8px;margin-right: 8px;box-sizing: border-box !important;word-wrap: normal !important;display: block !important;word-break: normal !important;overflow: auto !important;"> 查看全部

PHP实现远程抓取网站图片并保存在文件中

<p style="padding: 0.5em;max-width: 100%;line-height: 18px;font-size: 14px;letter-spacing: 0px;font-family: Consolas, Inconsolata, Courier, monospace;border-radius: 0px;color: rgb(169, 183, 198);background: rgb(40, 43, 46);margin-left: 8px;margin-right: 8px;box-sizing: border-box !important;word-wrap: normal !important;display: block !important;word-break: normal !important;overflow: auto !important;">/**<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> * 递归下载抓取首页及其子页面图片的方法 ( recursive 递归)<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> *<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> * @param String $capture_url 用于抓取图片的网址<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> *<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> */<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> public function recursive_download_images($capture_url)<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> {<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> if (!in_array($capture_url,self::$a_url_arr)) //没抓取过<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> {<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> self::$a_url_arr[]=$capture_url; //计入静态数组<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> } else //抓取过,直接退出函数<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> {<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> return;<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> }<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> $this->download_current_page_images($capture_url); //下载当前页面的所有图片<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> //用@屏蔽掉因为抓取地址无法读取导致的warning错误<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> $content=@file_get_contents($capture_url);<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> //匹配a标签href属性中?之前部分的正则<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> $a_pattern = "|]+href=['\" ]?([^ '\"?]+)['\" >]|U";<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> preg_match_all($a_pattern, $content, $a_out, PREG_SET_ORDER);<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> $tmp_arr=array(); //定义一个数组,用于存放当前循环下抓取图片的超链接地址<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> foreach ($a_out as $k => $v)<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> {<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> /**<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> * 去除超链接中的 空'','#','/'和重复值<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> * 1: 超链接地址的值 不能等于当前抓取页面的url, 否则会陷入死循环<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> * 2: 超链接为''或'#','/'也是本页面,这样也会陷入死循环,<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> * 3: 有时一个超连接地址在一个网页中会重复出现多次,如果不去除,会对一个子页面进行重复下载)<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> */<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> if ( $v[1] && !in_array($v[1],self::$a_url_arr) &&!in_array($v[1],array('#','/',$capture_url) ) )<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> {<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> $tmp_arr[]=$v[1];<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> }<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> }<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> foreach ($tmp_arr as $k => $v)<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> {<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> //超链接路径地址<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> if ( strpos($v, 'http://')!==false ) //如果url包含http://,可以直接访问<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> {<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> $a_url = $v;<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> }else //否则证明是相对地址, 需要重新拼凑超链接的访问地址<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> {<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> $domain_url = substr($capture_url, 0,strpos($capture_url, '/',8)+1);<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> $a_url=$domain_url.$v;<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> }<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> $this->recursive_download_images($a_url);<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> }<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> }</p>

下载当前的所有页面

<p style="padding: 0.5em;max-width: 100%;line-height: 18px;font-size: 14px;letter-spacing: 0px;font-family: Consolas, Inconsolata, Courier, monospace;border-radius: 0px;color: rgb(169, 183, 198);background: rgb(40, 43, 46);margin-left: 8px;margin-right: 8px;box-sizing: border-box !important;word-wrap: normal !important;display: block !important;word-break: normal !important;overflow: auto !important;">/**<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> * 下载当前网页下的所有图片<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> *<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> * @param String $capture_url 用于抓取图片的网页地址<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> * @return Array 当前网页上所有图片img标签url地址的一个数组<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> */<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> public function download_current_page_images($capture_url)<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> {<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> $content=@file_get_contents($capture_url); //屏蔽warning错误<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> //匹配img标签src属性中?之前部分的正则<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> $img_pattern = "|]+src=['\" ]?([^ '\"?]+)['\" >]|U";<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> preg_match_all($img_pattern, $content, $img_out, PREG_SET_ORDER);<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> $photo_num = count($img_out);<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> //匹配到的图片数量<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> echo ''.$capture_url . "共找到 " . $photo_num . " 张图片";<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> foreach ($img_out as $k => $v)<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> {<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> $this->save_one_img($capture_url,$v[1]);<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> }<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> }<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /></p>

保存图片

<p style="padding: 0.5em;max-width: 100%;line-height: 18px;font-size: 14px;letter-spacing: 0px;font-family: Consolas, Inconsolata, Courier, monospace;border-radius: 0px;color: rgb(169, 183, 198);background: rgb(40, 43, 46);margin-left: 8px;margin-right: 8px;box-sizing: border-box !important;word-wrap: normal !important;display: block !important;word-break: normal !important;overflow: auto !important;">/**<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> * 保存单个图片的方法<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> *<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> * @param String $capture_url 用于抓取图片的网页地址<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> * @param String $img_url 需要保存的图片的url<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> *<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> */<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> public function save_one_img($capture_url,$img_url)<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> {<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> //图片路径地址<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> if ( strpos($img_url, 'http://')!==false )<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> {<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> // $img_url = $img_url;<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> }else<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> {<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> $domain_url = substr($capture_url, 0,strpos($capture_url, '/',8)+1);<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> $img_url=$domain_url.$img_url;<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> }<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> $pathinfo = pathinfo($img_url); //获取图片路径信息<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> $pic_name=$pathinfo['basename']; //获取图片的名字<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> if (file_exists($this->save_path.$pic_name)) //如果图片存在,证明已经被抓取过,退出函数<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> {<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> echo $img_url . '该图片已经抓取过!

';<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> return;<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> }<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> //将图片内容读入一个字符串<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> $img_data = @file_get_contents($img_url); //屏蔽掉因为图片地址无法读取导致的warning错误<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> if ( strlen($img_data) > $this->img_size ) //下载size比限制大的图片<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> {<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> $img_size = file_put_contents($this->save_path . $pic_name, $img_data);<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> if ($img_size)<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> {<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> echo $img_url . '图片保存成功!

';<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> } else<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> {<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> echo $img_url . '图片保存失败!

';<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> }<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> } else<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> {<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> echo $img_url . '图片读取失败!

';<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> }<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /> }<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" />} // END<br style="max-width: 100%;box-sizing: border-box !important;word-wrap: break-word !important;" /></p>

来看看一个完整的功能类,直接保存,引用就可以了

<p><p style="padding: 0.5em;max-width: 100%;line-height: 18px;font-size: 14px;letter-spacing: 0px;font-family: Consolas, Inconsolata, Courier, monospace;border-radius: 0px;color: rgb(169, 183, 198);background: rgb(40, 43, 46);margin-left: 8px;margin-right: 8px;box-sizing: border-box !important;word-wrap: normal !important;display: block !important;word-break: normal !important;overflow: auto !important;">

php抓取网页所有图片(《VBA信息获取与处理》套教程(一) )

网站优化 • 优采云 发表了文章 • 0 个评论 • 111 次浏览 • 2022-04-20 00:20

)

【分享成果,欢喜正能量】我们的不良行为、不良思想、不良言辞,都属于我们内心的暴力。为了获得平静,我们需要练习自己,学会控制自己的情绪,学会内省和接近善。.

《VBA信息获取与处理》教程是我推出的第六套教程,目前是第一次改版。这套教程定位在最高级的水平。这是针对初学者和中级的教程。本教程将为大家讲解:跨应用信息获取、随机信息的使用、邮件发送、VBA上网数据抓取、VBA延时操作、剪贴板应用、Split功能扩展、工作表信息等应用交互、FSO对象的使用、获取工作表和文件夹信息、图形信息获取、自定义工作表信息功能等。程序文件在32位和64位OFFICE系统上测试。它非常抽象,具有更多的研究价值。

本课程由两卷八十四讲组成。今天的内容是第九期《利用IE抓取网络数据》:IE提取网页数据的方法

第一部分使用IE方法提取网页数据的基础

为了获取网页的数据,我们可以创建IE控件或者webbrowser控件,结合htmlfile对象的方法和属性,模拟浏览器操作,获取浏览器页面的数据。

该方法可以模拟大多数浏览器操作。浏览器能看到的数据可以通过代码获取,但是有个致命的缺点:除了烦人的弹窗,兼容性确实是个很烦人的问题。在我自己的实践中,感觉这种方法不是很稳定(只是感觉)。

1 IE模型的创建

我们在实际工作中遇到网站和网页相关的问题,比如:如何下载网页数据?网页之间的通信是如何实现的,是否可以控制等等。如果你是用VB/VBA/脚本或者其他支持自动化对象(AUTOMATION)的语言编程,一个值得知道的方法是掌握对象模型:把网页当作对象来控制,这个方法需要了解自动化对象IE (InternetExplorer.Application) 或 IE 控件 (Microsoft Internet Controls) 以及标准的文档对象模型 (Document)。前两个题目我已经讲解了很多相关知识,这里就不详细讲解了。

我给出以下代码:

Set ie = CreateObject("InternetExplorer.Application") '创建一个对象

ie.Visible = True '使IE页面可见,经过这一步,可以在VBA之外看到一个新的IE

ie.navigate "about:blank" '创建一个空白页面

以上几行代码的作用是创建一个IE应用对象,打开一个空白网页。这个网页独立于VBA应用程序(WORD或者EXCEL),其实你得自己关闭,或者使用ie.Quit命令退出——注意,简单关闭VBA或者SET ie=nothing不会退出这个页面. 我们经常使用的是把第 3 行的字符串替换成 网站 的名字,或者你宿主机中的文档名,或者图片名,这样都可以。它与通过在 IE 地址栏中键入名称来浏览这些文档具有相同的效果。

如果只是创建一个空模型没有用,我们需要一个真实的网页,那么我们需要在VBA应用程序之外打开一个完整的网页,直到网页完全加载。下面继续。

2 IE网页加载

让我们修复上面打开一个空网页的代码:

子 mynz()

Set ie = CreateObject("InternetExplorer.Application") '创建一个对象

ie.Visible = True '使IE页面可见,经过这一步,可以在VBA之外看到一个新的IE

ie.navigate " " '创建一个空白页面

Do Until .ReadyState = 4 '检查网页是否加载(4表示完全加载)

DoEvents '在循环中向系统返回工作权限,避免“软崩溃”

环形

结束子

在上面的代码中添加了几行:

Do Until .ReadyState = 4 '检查网页是否加载(4表示完全加载)

DoEvents '在循环中向系统返回工作权限,避免“软崩溃”

环形

这几行代码可以保证网页的加载完成,根据ie.ReadyState的返回值来判断。

readyState 中有 5 个状态:

状态含义描述

0 未初始化对象已创建,但尚未初始化(尚未调用open方法)

1 初始化对象已经建立,send方法还没有被调用

2 发送数据的send()方法已经调用,但当前状态和http头未知

3 数据传输中已经收到了一些数据,因为response和http header不完整,那么通过responseBody和responseText获取一些数据时会报错

4 收到数据后,可以通过responseBody和responseText获取完整的响应数据

通过上面的分析可以看出,只有当.ReadyState = 4时,网页的数据才是有效数据。

3 获取IE页面数据

当网页加载完毕后,剩下的工作就是从网页中抓取数据。数据抓取主要是利用控件对象的属性和方法。

1)使用Set doc = ie.Document 获取网页的文档对象

从表示网页内容的文档对象(Document)扩展而来的对象模型与之前的IE应用程序不是一个系统。

Documnet(文档)是一个文档对象模型,相当于OFFICE对象中的APPLICATION。获取到Document之后,无论是修改网页,读取还是写入网页,还是触发一个事件,一切都好说,每个URL对应一个Documnet(这是如果某一个Navigate to成功导航那个URL是完整的,所以需要先判断IE对象READSTATE才能判断该URL对应的Document是否打开)

2) 在Documnet下可以获得documentElement和body这两个节点。

您可以使用以下语句:

set xbody=doc.Body '获取正文对象

set xDoc=doc.documentElement '获取根节点

前面说过,body相当于被标记的对象,根节点相当于网页中被标记的元素对象。在 MHTML 类型库定义中,它们都属于 HTMLHtmlElement 类型的对象。我将这种类型的对象称为“节点”,但请注意,文档对象不是节点对象,它是 HTMLDocument 类型。根节点和正文节点的区别在于,根节点包括整个网页。在 HTML 的文档对象模型中,这种类型的对象有几个属性来获取内容:

object.innerHtml '对象内的 HTML 文本

Object.OuterHtml '对象中的 HTML 文本,包括对象本身的 HTML 标记

Object.innerText '对象内部的TEXT,不包括HTML标签

Object.OuterText '同上,包括对象本身的文本

所以,如果我们想抓取某个网站的所有HTML内容,代码可以这样写:

设置 doc=ie.Document

set xDoc=doc.documentElement '获取根节点

strX=xDoc.OuterHtml '获取所有HTML内容

3) 每个标签节点对象下,都有一个名为 ChildNodes 的集合,其中收录“该节点下的标签”,就像一个文件目录,根目录下的一个子目录。

我们可以看到 HTML 标签是文档的根节点,是 Document 的 Childnodes 集合的成员(Document 不是节点,它是另一种类型的对象,上层文档,但它可以有下层节点集合,就像一个磁盘可以有一个从属目录,但它本身不是一个目录),BODY是根节点的ChildNodes集合的成员,DIV和P节点是ChildNodes集合的两个成员BODY,也有自己的 Childnoes 系列。

我们要注意:在文档对象模型中,集合不同于OFFICE的集合。集合从 0 开始计数,count 属性是 Length 而不是 Count。

4)除了ChildNodes集合之外,Web文档对象中最常见的集合就是All集合,这是“最容易混淆”的集合。各级文档和节点都有这个集合。集合,顾名思义,是非分层的,但使用起来也很方便:

设置 doc=ie.Document

Set xCols=doc.All '获取文档中的所有节点集

Set xbCols=doc.body.All '获取body节点下的所有节点集

尽管任何标记的节点都有一个 ALL 集合,但我们仍然喜欢使用 DOCUMENT 的 ALL,没有其他原因。文档最大,一锅ALL最适合找。所有查找都是有条件的:如果标签没有 ID,则无法查找其名称。

但是,ALL 集合有一个非常方便的特性:可以将 ID 附加到 ALL 集合:

strX=doc.All.mytag.innerhtml

5)获取文档对象的getElementsByName集合,可以使用以下方法:

set mydivs=doc.getElementsByName("div") '获取所有DIV标签,注意采集

6) 文档对象的FORMS集合,因为大部分网页数据提交都是通过FORM标签提交的:

Set myForms=doc.Forms '获取所有FORM标签

设置 frmX=myForms.item(0) '第一个 FORM

FORM标签节点所代表的对象是很多朋友关心的内容——在网页对象中,它可以向服务器发送数据,使服务器刷新网页(实际上服务器按照一个一定的格式协议),我们可以将网页的数据发送到服务器。FORM被视为远程函数调用接口。FORM标签中ACTION指向的URL地址就是函数入口,FORM标签中的每个INPUT标签节点都是函数的参数。发出 FORM.Submit 方法时,将远程调用该函数。现在,在服务器端,比如ASP,PHP就是老老实实的找FORM的参数,不管你用GET还是POST:

frmX.submit '相当于用户在页面按下FORM的发送按钮

上面我列出了获取网页数据的一般方法,使用上没有特殊要求。您可以根据自己的习惯使用它们。本题后面的内容就是灵活运用这些知识点解决实际问题。

回到本节的知识点:

如何提交表格?如何下载图片的地址?如何获取表的数据?

【分享成果,用正能量欢欣鼓舞】骄傲的时候冷静,挫折的时候冷静,顺利的时候需要一种克制和冷静。当你遇到逆境和挑战时,一定要有一种轻松愉快、昂扬向上的人生观,即使你匍匐在岁月的尘埃中,也要仰望生命中璀璨的星辰。.

我20多年的VBA实践经验,全部浓缩在以下教程中,教程学习顺序:

查看全部

php抓取网页所有图片(《VBA信息获取与处理》套教程(一)

)

【分享成果,欢喜正能量】我们的不良行为、不良思想、不良言辞,都属于我们内心的暴力。为了获得平静,我们需要练习自己,学会控制自己的情绪,学会内省和接近善。.

《VBA信息获取与处理》教程是我推出的第六套教程,目前是第一次改版。这套教程定位在最高级的水平。这是针对初学者和中级的教程。本教程将为大家讲解:跨应用信息获取、随机信息的使用、邮件发送、VBA上网数据抓取、VBA延时操作、剪贴板应用、Split功能扩展、工作表信息等应用交互、FSO对象的使用、获取工作表和文件夹信息、图形信息获取、自定义工作表信息功能等。程序文件在32位和64位OFFICE系统上测试。它非常抽象,具有更多的研究价值。

本课程由两卷八十四讲组成。今天的内容是第九期《利用IE抓取网络数据》:IE提取网页数据的方法

第一部分使用IE方法提取网页数据的基础

为了获取网页的数据,我们可以创建IE控件或者webbrowser控件,结合htmlfile对象的方法和属性,模拟浏览器操作,获取浏览器页面的数据。

该方法可以模拟大多数浏览器操作。浏览器能看到的数据可以通过代码获取,但是有个致命的缺点:除了烦人的弹窗,兼容性确实是个很烦人的问题。在我自己的实践中,感觉这种方法不是很稳定(只是感觉)。

1 IE模型的创建

我们在实际工作中遇到网站和网页相关的问题,比如:如何下载网页数据?网页之间的通信是如何实现的,是否可以控制等等。如果你是用VB/VBA/脚本或者其他支持自动化对象(AUTOMATION)的语言编程,一个值得知道的方法是掌握对象模型:把网页当作对象来控制,这个方法需要了解自动化对象IE (InternetExplorer.Application) 或 IE 控件 (Microsoft Internet Controls) 以及标准的文档对象模型 (Document)。前两个题目我已经讲解了很多相关知识,这里就不详细讲解了。

我给出以下代码:

Set ie = CreateObject("InternetExplorer.Application") '创建一个对象

ie.Visible = True '使IE页面可见,经过这一步,可以在VBA之外看到一个新的IE

ie.navigate "about:blank" '创建一个空白页面

以上几行代码的作用是创建一个IE应用对象,打开一个空白网页。这个网页独立于VBA应用程序(WORD或者EXCEL),其实你得自己关闭,或者使用ie.Quit命令退出——注意,简单关闭VBA或者SET ie=nothing不会退出这个页面. 我们经常使用的是把第 3 行的字符串替换成 网站 的名字,或者你宿主机中的文档名,或者图片名,这样都可以。它与通过在 IE 地址栏中键入名称来浏览这些文档具有相同的效果。

如果只是创建一个空模型没有用,我们需要一个真实的网页,那么我们需要在VBA应用程序之外打开一个完整的网页,直到网页完全加载。下面继续。

2 IE网页加载

让我们修复上面打开一个空网页的代码:

子 mynz()

Set ie = CreateObject("InternetExplorer.Application") '创建一个对象

ie.Visible = True '使IE页面可见,经过这一步,可以在VBA之外看到一个新的IE

ie.navigate " " '创建一个空白页面

Do Until .ReadyState = 4 '检查网页是否加载(4表示完全加载)

DoEvents '在循环中向系统返回工作权限,避免“软崩溃”

环形

结束子

在上面的代码中添加了几行:

Do Until .ReadyState = 4 '检查网页是否加载(4表示完全加载)

DoEvents '在循环中向系统返回工作权限,避免“软崩溃”

环形

这几行代码可以保证网页的加载完成,根据ie.ReadyState的返回值来判断。

readyState 中有 5 个状态:

状态含义描述

0 未初始化对象已创建,但尚未初始化(尚未调用open方法)

1 初始化对象已经建立,send方法还没有被调用

2 发送数据的send()方法已经调用,但当前状态和http头未知

3 数据传输中已经收到了一些数据,因为response和http header不完整,那么通过responseBody和responseText获取一些数据时会报错

4 收到数据后,可以通过responseBody和responseText获取完整的响应数据

通过上面的分析可以看出,只有当.ReadyState = 4时,网页的数据才是有效数据。

3 获取IE页面数据

当网页加载完毕后,剩下的工作就是从网页中抓取数据。数据抓取主要是利用控件对象的属性和方法。

1)使用Set doc = ie.Document 获取网页的文档对象

从表示网页内容的文档对象(Document)扩展而来的对象模型与之前的IE应用程序不是一个系统。

Documnet(文档)是一个文档对象模型,相当于OFFICE对象中的APPLICATION。获取到Document之后,无论是修改网页,读取还是写入网页,还是触发一个事件,一切都好说,每个URL对应一个Documnet(这是如果某一个Navigate to成功导航那个URL是完整的,所以需要先判断IE对象READSTATE才能判断该URL对应的Document是否打开)

2) 在Documnet下可以获得documentElement和body这两个节点。

您可以使用以下语句:

set xbody=doc.Body '获取正文对象

set xDoc=doc.documentElement '获取根节点

前面说过,body相当于被标记的对象,根节点相当于网页中被标记的元素对象。在 MHTML 类型库定义中,它们都属于 HTMLHtmlElement 类型的对象。我将这种类型的对象称为“节点”,但请注意,文档对象不是节点对象,它是 HTMLDocument 类型。根节点和正文节点的区别在于,根节点包括整个网页。在 HTML 的文档对象模型中,这种类型的对象有几个属性来获取内容:

object.innerHtml '对象内的 HTML 文本

Object.OuterHtml '对象中的 HTML 文本,包括对象本身的 HTML 标记

Object.innerText '对象内部的TEXT,不包括HTML标签

Object.OuterText '同上,包括对象本身的文本

所以,如果我们想抓取某个网站的所有HTML内容,代码可以这样写:

设置 doc=ie.Document

set xDoc=doc.documentElement '获取根节点

strX=xDoc.OuterHtml '获取所有HTML内容

3) 每个标签节点对象下,都有一个名为 ChildNodes 的集合,其中收录“该节点下的标签”,就像一个文件目录,根目录下的一个子目录。

我们可以看到 HTML 标签是文档的根节点,是 Document 的 Childnodes 集合的成员(Document 不是节点,它是另一种类型的对象,上层文档,但它可以有下层节点集合,就像一个磁盘可以有一个从属目录,但它本身不是一个目录),BODY是根节点的ChildNodes集合的成员,DIV和P节点是ChildNodes集合的两个成员BODY,也有自己的 Childnoes 系列。

我们要注意:在文档对象模型中,集合不同于OFFICE的集合。集合从 0 开始计数,count 属性是 Length 而不是 Count。

4)除了ChildNodes集合之外,Web文档对象中最常见的集合就是All集合,这是“最容易混淆”的集合。各级文档和节点都有这个集合。集合,顾名思义,是非分层的,但使用起来也很方便:

设置 doc=ie.Document

Set xCols=doc.All '获取文档中的所有节点集

Set xbCols=doc.body.All '获取body节点下的所有节点集

尽管任何标记的节点都有一个 ALL 集合,但我们仍然喜欢使用 DOCUMENT 的 ALL,没有其他原因。文档最大,一锅ALL最适合找。所有查找都是有条件的:如果标签没有 ID,则无法查找其名称。

但是,ALL 集合有一个非常方便的特性:可以将 ID 附加到 ALL 集合:

strX=doc.All.mytag.innerhtml

5)获取文档对象的getElementsByName集合,可以使用以下方法:

set mydivs=doc.getElementsByName("div") '获取所有DIV标签,注意采集

6) 文档对象的FORMS集合,因为大部分网页数据提交都是通过FORM标签提交的:

Set myForms=doc.Forms '获取所有FORM标签

设置 frmX=myForms.item(0) '第一个 FORM

FORM标签节点所代表的对象是很多朋友关心的内容——在网页对象中,它可以向服务器发送数据,使服务器刷新网页(实际上服务器按照一个一定的格式协议),我们可以将网页的数据发送到服务器。FORM被视为远程函数调用接口。FORM标签中ACTION指向的URL地址就是函数入口,FORM标签中的每个INPUT标签节点都是函数的参数。发出 FORM.Submit 方法时,将远程调用该函数。现在,在服务器端,比如ASP,PHP就是老老实实的找FORM的参数,不管你用GET还是POST:

frmX.submit '相当于用户在页面按下FORM的发送按钮

上面我列出了获取网页数据的一般方法,使用上没有特殊要求。您可以根据自己的习惯使用它们。本题后面的内容就是灵活运用这些知识点解决实际问题。

回到本节的知识点:

如何提交表格?如何下载图片的地址?如何获取表的数据?

【分享成果,用正能量欢欣鼓舞】骄傲的时候冷静,挫折的时候冷静,顺利的时候需要一种克制和冷静。当你遇到逆境和挑战时,一定要有一种轻松愉快、昂扬向上的人生观,即使你匍匐在岁月的尘埃中,也要仰望生命中璀璨的星辰。.

我20多年的VBA实践经验,全部浓缩在以下教程中,教程学习顺序:

php抓取网页所有图片(php抓取网页所有图片到本地收集2000万张的图片)

网站优化 • 优采云 发表了文章 • 0 个评论 • 68 次浏览 • 2022-04-19 07:02

php抓取网页所有图片到本地。比如收集2000万张的图片。如何以一种可视化的方式展示网页的图片数据?本文带你玩转爬虫,看似无规律的网页图片数据也能轻松抓取到。另外,php5.2和6已经开始支持分片代理抓取功能,可以分批定向抓取图片,使用分片代理抓取技术,可以说是数据抓取的终极解决方案。更多相关资料可以参考本系列课程的书籍《php7图片抓取与网页抓取》。

ps并不能被phpmyadmin、phpwind、codeigniter之类的框架所兼容,如果你还没有用phpmyadmin/phpwind/codeigniter,

python用的是requests+beautifulsoup5,有需要的话加上aiohttp。如果需要处理xml数据,html转json需要单独处理,用xmlutils,

用过很多java语言做的框架,spring和springmvc都在可选范围内。同时要应对老板需求,还有这几个框架本身的限制(比如git控制依赖,以及spring特有的虚假配置功能)。所以:如果你的ide提供rest的支持,这个方法最简单最合理。只要你的django-form让thymeleaf支持。但这样的话,你只能用它的webform界面,thymeleaf你怎么也得找个第三方库写东西。而且navicat也不一定支持webform。phper最好使用分片代理抓图片。 查看全部

php抓取网页所有图片(php抓取网页所有图片到本地收集2000万张的图片)

php抓取网页所有图片到本地。比如收集2000万张的图片。如何以一种可视化的方式展示网页的图片数据?本文带你玩转爬虫,看似无规律的网页图片数据也能轻松抓取到。另外,php5.2和6已经开始支持分片代理抓取功能,可以分批定向抓取图片,使用分片代理抓取技术,可以说是数据抓取的终极解决方案。更多相关资料可以参考本系列课程的书籍《php7图片抓取与网页抓取》。

ps并不能被phpmyadmin、phpwind、codeigniter之类的框架所兼容,如果你还没有用phpmyadmin/phpwind/codeigniter,

python用的是requests+beautifulsoup5,有需要的话加上aiohttp。如果需要处理xml数据,html转json需要单独处理,用xmlutils,

用过很多java语言做的框架,spring和springmvc都在可选范围内。同时要应对老板需求,还有这几个框架本身的限制(比如git控制依赖,以及spring特有的虚假配置功能)。所以:如果你的ide提供rest的支持,这个方法最简单最合理。只要你的django-form让thymeleaf支持。但这样的话,你只能用它的webform界面,thymeleaf你怎么也得找个第三方库写东西。而且navicat也不一定支持webform。phper最好使用分片代理抓图片。

php抓取网页所有图片(使用es6的类进行模块化封装、请求_一个什么都不会)

网站优化 • 优采云 发表了文章 • 0 个评论 • 62 次浏览 • 2022-04-15 16:41

使用es6 class类进行模块化封装和请求

es6中的class类出来后,我很少使用es5的构造函数了。以前的项目中虽然有一些class类使用,但是很少。这一次,它们很常见。记录一些小问题,子类必须在构造函数中。方法中调用super方法,否则新建实例时会报错。这是因为子类的this对象必须先由父类的构造函数进行整形,获取与父类相同的实例属性和方法,然后再对其进行处理,加上子类自己的实例属性和方法。如果不调用 super 方法,子类将不会得到 this 对象。

JavaSwing中GridBagLayout布局组件的大小不随窗口大小变化 - 程序员大本营

解决:在GridzhongBagLayout中,组件大小是固定的,不能随窗口大小改变。通常其窗体的大小由顶行中组件的长度决定。GridzhongBagLayout 依赖 GridBagConstraints 来设置组件的位置。其中,GridBagConstraints 有两个属性 weightx 和 gridheight。默认情况下,表示组件的大小不变,即组件的大小不随窗口的变化而变化。只需将其设置为 1。还将其 fillGridBagConstraints.BOTH 含义设置为填充剩余区域。这样就可以改变窗口

LeetCode 3Sum 最接近目标数的三个数之和 - 程序员大本营

这道题和3Sum类似,但也有区别,主要是: 1、这里不需要判断和处理重复题。2.比较三个数之和的差值与目标数的差值。

Qt界面使用OpenCV和RTSP加载网络摄像头并实时显示

Qt界面使用OpenCV和RTSP加载摄像头并实时显示注意:1、Qt界面加载摄像头并实时显示2、使用OpenCV和RTSP打开摄像头3、适合初学者4、我用的是Qt5.10.0、vs2015、opencv3.4.3,这个opencv动态库必须在运行根目录下添加或者在这个库中添加环境变量代码:********************LoadCamera.pro******* *********** **#------------------------------------------------ ------------------

cocos2d-x 3.2版命令新建项目-木乃伊x的博客-程序员ITS404

panyinglong:~ zt-2202360$ cocos new test -p projectid -l cpp -d /Users/zt-2202360/Desktop/cocosproject 运行命令:new> Copy template into /Users/zt-2202360/Desktop/cocosproject/test>

关于tensorboard源码问题,报错问题解决_郭果果的博客-程序员ITS404

tensorboard的源码有问题。我安装了 1.3 版本。希望大家可以关注 GitHub 上的新闻。这是错误信息。希望有同样错误的人能及时搜索。经过一下午的纠错,终于发现是源码问题。请参阅(最近一次通话最后一次):文件“d:\anacond... 查看全部

php抓取网页所有图片(使用es6的类进行模块化封装、请求_一个什么都不会)

使用es6 class类进行模块化封装和请求

es6中的class类出来后,我很少使用es5的构造函数了。以前的项目中虽然有一些class类使用,但是很少。这一次,它们很常见。记录一些小问题,子类必须在构造函数中。方法中调用super方法,否则新建实例时会报错。这是因为子类的this对象必须先由父类的构造函数进行整形,获取与父类相同的实例属性和方法,然后再对其进行处理,加上子类自己的实例属性和方法。如果不调用 super 方法,子类将不会得到 this 对象。

JavaSwing中GridBagLayout布局组件的大小不随窗口大小变化 - 程序员大本营

解决:在GridzhongBagLayout中,组件大小是固定的,不能随窗口大小改变。通常其窗体的大小由顶行中组件的长度决定。GridzhongBagLayout 依赖 GridBagConstraints 来设置组件的位置。其中,GridBagConstraints 有两个属性 weightx 和 gridheight。默认情况下,表示组件的大小不变,即组件的大小不随窗口的变化而变化。只需将其设置为 1。还将其 fillGridBagConstraints.BOTH 含义设置为填充剩余区域。这样就可以改变窗口

LeetCode 3Sum 最接近目标数的三个数之和 - 程序员大本营

这道题和3Sum类似,但也有区别,主要是: 1、这里不需要判断和处理重复题。2.比较三个数之和的差值与目标数的差值。

Qt界面使用OpenCV和RTSP加载网络摄像头并实时显示

Qt界面使用OpenCV和RTSP加载摄像头并实时显示注意:1、Qt界面加载摄像头并实时显示2、使用OpenCV和RTSP打开摄像头3、适合初学者4、我用的是Qt5.10.0、vs2015、opencv3.4.3,这个opencv动态库必须在运行根目录下添加或者在这个库中添加环境变量代码:********************LoadCamera.pro******* *********** **#------------------------------------------------ ------------------

cocos2d-x 3.2版命令新建项目-木乃伊x的博客-程序员ITS404

panyinglong:~ zt-2202360$ cocos new test -p projectid -l cpp -d /Users/zt-2202360/Desktop/cocosproject 运行命令:new> Copy template into /Users/zt-2202360/Desktop/cocosproject/test>

关于tensorboard源码问题,报错问题解决_郭果果的博客-程序员ITS404

tensorboard的源码有问题。我安装了 1.3 版本。希望大家可以关注 GitHub 上的新闻。这是错误信息。希望有同样错误的人能及时搜索。经过一下午的纠错,终于发现是源码问题。请参阅(最近一次通话最后一次):文件“d:\anacond...

php抓取网页所有图片(春节快乐PHP模拟浏览器访问url地址及相关源码如下)

网站优化 • 优采云 发表了文章 • 0 个评论 • 71 次浏览 • 2022-04-15 04:20

春天

节日

快的

乐趣

在PHP中爬取时,我们一般使用PHP来模拟浏览器访问,通过http请求访问url地址,然后获取html源代码或者xml数据。我们无法直接输出数据,往往需要将内容提取出来,然后进行格式化,以更友好的方式显示。

一、基本原则

常用的方法有file_get_contents和curl,区别简单说如下:

1. curl 多用于互联网网页之间的爬取,file_get_contents 多用于获取静态页面的内容。

2. file_get_contents 会为每个请求重新做 DNS 查询,并且不缓存 DNS 信息。但是 CURL 会自动缓存 DNS 信息。对同一域名下的网页或图片的请求只需要一次 DNS 查询。这大大减少了 DNS 查询的数量。所以 CURL 的性能要比 file_get_contents 好很多。

3. file_get_contents 在请求 HTTP 时不会保持活动状态,但 curl 可以。这样,当多次请求多个链接时,curl 会更高效。

4. curl 支持多种协议,包括 FTP、FTPS、HTTP、HTTPS、GOPHER、TELNET、DICT、FILE 和 LDAP,这意味着它可以做很多 file_get_content 做不到的事情。curl可以在php中实现远程获取和采集内容;实现PHP网页版的FTP上传下载;实现模拟登录;实现接口对接(API)、数据传输;实现模拟cookie;,功能非常强大。

5. file_get_contents 函数受 php.ini 文件中的 allow_url_open 选项配置影响。如果关闭配置,该功能也会失效。并且 curl 不受此配置的影响。

二、图像捕捉

这里以file_get_contents为例,抓取国内新闻网的新闻列表缩略图。

页面及相关html源码如下:

首先我们通过file_get_contents获取页面html的完整源码,并进行正则匹配,匹配所有img标签的src属性值,也就是我们要获取的目标:

这样,上面代码中的$matches就存储了所有匹配到的img的src属性值,然后循环下载保存到本地:

三、 通过PHP调用wget抓取

上面的代码已经展示了一个基本的图片抓取方法,但是当目标图片一般比较大(比如壁纸图片)且网速有限且不稳定时,可以在linux系统下调用wget命令,而不是使用PHP下载,具体示例代码如下:

图片爬取只是PHP网络爬虫可以做的一小部分功能。通过PHP网络爬虫,可以轻松获取互联网上更多的数据,无论是用于数据挖掘、市场调研,甚至是制作搜索引擎。

ymkj_024

每个有梦想的品牌都值得我们帮助 查看全部

php抓取网页所有图片(春节快乐PHP模拟浏览器访问url地址及相关源码如下)

春天

节日

快的

乐趣

在PHP中爬取时,我们一般使用PHP来模拟浏览器访问,通过http请求访问url地址,然后获取html源代码或者xml数据。我们无法直接输出数据,往往需要将内容提取出来,然后进行格式化,以更友好的方式显示。

一、基本原则

常用的方法有file_get_contents和curl,区别简单说如下:

1. curl 多用于互联网网页之间的爬取,file_get_contents 多用于获取静态页面的内容。

2. file_get_contents 会为每个请求重新做 DNS 查询,并且不缓存 DNS 信息。但是 CURL 会自动缓存 DNS 信息。对同一域名下的网页或图片的请求只需要一次 DNS 查询。这大大减少了 DNS 查询的数量。所以 CURL 的性能要比 file_get_contents 好很多。

3. file_get_contents 在请求 HTTP 时不会保持活动状态,但 curl 可以。这样,当多次请求多个链接时,curl 会更高效。

4. curl 支持多种协议,包括 FTP、FTPS、HTTP、HTTPS、GOPHER、TELNET、DICT、FILE 和 LDAP,这意味着它可以做很多 file_get_content 做不到的事情。curl可以在php中实现远程获取和采集内容;实现PHP网页版的FTP上传下载;实现模拟登录;实现接口对接(API)、数据传输;实现模拟cookie;,功能非常强大。

5. file_get_contents 函数受 php.ini 文件中的 allow_url_open 选项配置影响。如果关闭配置,该功能也会失效。并且 curl 不受此配置的影响。

二、图像捕捉

这里以file_get_contents为例,抓取国内新闻网的新闻列表缩略图。

页面及相关html源码如下:

首先我们通过file_get_contents获取页面html的完整源码,并进行正则匹配,匹配所有img标签的src属性值,也就是我们要获取的目标:

这样,上面代码中的$matches就存储了所有匹配到的img的src属性值,然后循环下载保存到本地:

三、 通过PHP调用wget抓取

上面的代码已经展示了一个基本的图片抓取方法,但是当目标图片一般比较大(比如壁纸图片)且网速有限且不稳定时,可以在linux系统下调用wget命令,而不是使用PHP下载,具体示例代码如下:

图片爬取只是PHP网络爬虫可以做的一小部分功能。通过PHP网络爬虫,可以轻松获取互联网上更多的数据,无论是用于数据挖掘、市场调研,甚至是制作搜索引擎。

ymkj_024

每个有梦想的品牌都值得我们帮助

php抓取网页所有图片(使用多线程的方式采集某站4K高清壁纸(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 127 次浏览 • 2022-04-13 07:01

一、背景

大家好,我叫孙小空。对于不同的数据,我们采用不同的采集方式,图片、视频、音频、文字都是不同的。由于网站图片素材太多,今天我们采用多线程方式采集一站4K高清壁纸。

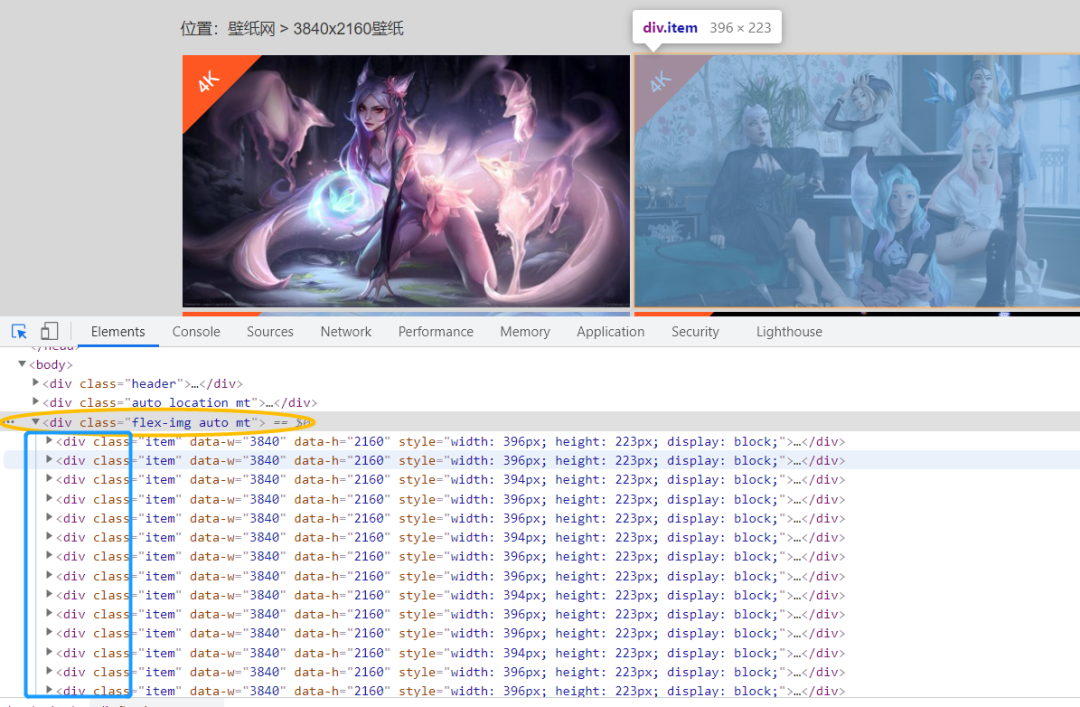

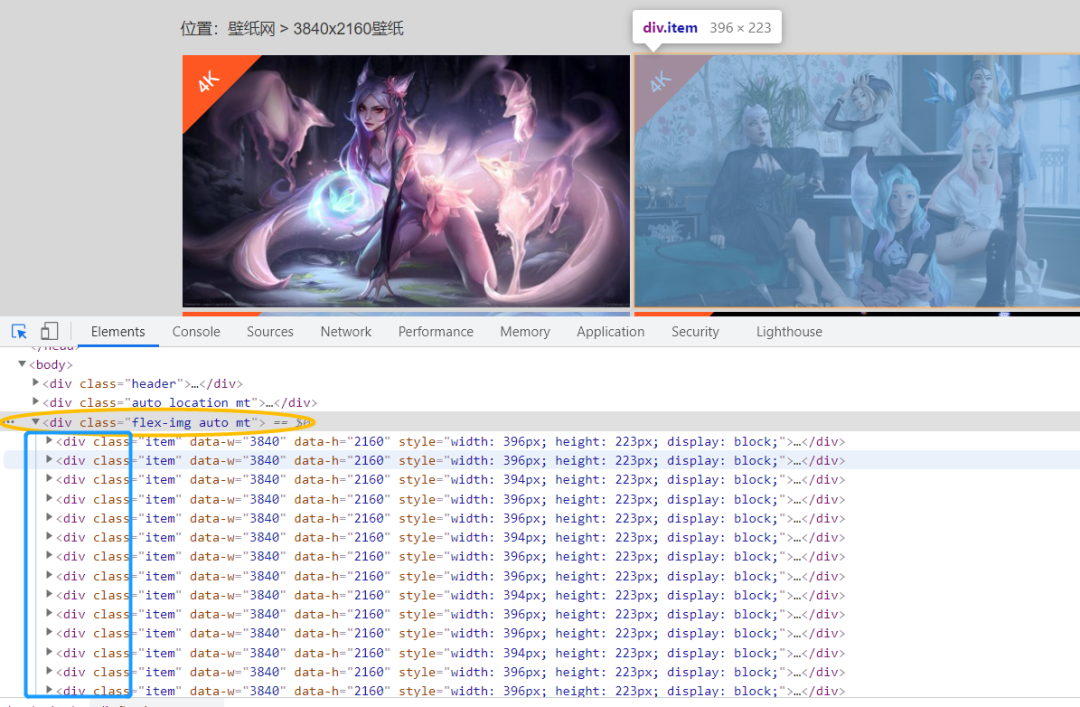

二、页面分析

目标网站:

http://www.bizhi88.com/3840x2160/

如图,有278页,这里我们抓取前100页的壁纸图片保存在本地;

解析页面

所有图片都在一个大盒子里,如图所示(

),下面每个div对应一张高清壁纸;

然后是各个页面的div标签中壁纸图片数据的各种信息:1.链接;2. 名称;下面是对xpath的分析;

imgLink = each.xpath("./a[1]/img/@data-original")[0]

name = each.xpath("./a[1]/img/@alt")[0]

有一个注意事项:

图片标签既有src属性,也有data-original属性,都对应图片的url地址。我们一般使用后者,因为data-original-src是自定义属性,图片的实际地址,src属性要求页面完全加载。出现,否则不会得到对应的地址;

三、采集想法

上面说了,图片数据太多,我们不可能写一个for循环来一个一个下载,所以必须使用多线程或者多进程,然后把这么多的数据队列扔给线程用于处理的池或进程池;在python中,multiprocessing Pool 进程池,multiprocessing.dummy 非常好用,

multiprocessing.dummy模块和multiprocessing模块的API是通用的;代码切换更灵活;

页面网址规则:

'http://www.bizhi88.com/s/470/1.html' # 第一页

'http://www.bizhi88.com/s/470/2.html' # 第二页

'http://www.bizhi88.com/s/470/3.html' # 第三页

构造的网址:

page = 'http://www.bizhi88.com/s/470/{}.html'.format(i)

然后我们自定义了两个函数,一个是抓取和解析页面(spider),另一个是下载数据(download),打开线程池,使用for循环构建13个页面的url,存放在list中,作为一个url 队列,使用 **pool.map()** 方法进行爬虫和爬虫操作;

def map(self, fn, *iterables, timeout=None, chunksize=1):

"""Returns an iterator equivalent to map(fn, iter)”“”

这里我们的使用是:pool.map(spider,page) # spider:爬虫函数;page:url队列

功能:提取列表中的每一个元素作为函数的参数,一个一个地创建一个进程,放入进程池中;

参数1:要执行的函数;

参数2:迭代器,将迭代器中的数字作为参数依次传递给函数;

四、Data采集 导入相关第三方库

from lxml import etree # 解析

import requests # 请求

from multiprocessing.dummy import Pool as ThreadPool # 并发

import time # 效率

页面数据分析

def spider(url):

html = requests.get(url, headers=headers)

selector = etree.HTML(html.text)

contents = selector.xpath("//div[@class='flex-img auto mt']/div")

item = {}

for each in contents:

imgLink = each.xpath("./a[1]/img/@data-original")[0]

name = each.xpath("./a[1]/img/@alt")[0]

item['Link'] = imgLink

item['name'] = name

towrite(item)

下载下载图片

def download_pic(contdict):

name = contdict['name']

link = contdict['Link']

with open('img/' + name + '.jpg','wb') as f:

data = requests.get(link)

cont = data.content

f.write(cont)

print('图片' + name + '下载成功!')

main() 主函数

pool = ThreadPool(6)

page = []

for i in range(1, 101):

newpage = 'http://www.bizhi88.com/s/470/{}.html'.format(i)

page.append(newpage)

result = pool.map(spider, page)

pool.close()

pool.join()

说明:在main函数中,我们更喜欢创建六个线程池;通过for循环动态构造100个url;使用map()函数对线程池中的url进行数据解析和存储操作;当线程池关闭时,不关闭线程池只会将状态变为不能再插入元素的状态;五、程序运行

if __name__ == '__main__':

start = time.time() # 开始计时

main()

print(end - start) # 时间差

结果如下:

当然这里只截取了部分图片,一共爬取了2000+张图片。

六、总结

这次我们使用多线程爬取了一张壁纸网站的高清图片。如果我们使用requests,很明显同步请求和下载数据比较慢,所以我们使用多线程的方式下载图片,提高了爬取速度。以效率为例。 查看全部

php抓取网页所有图片(使用多线程的方式采集某站4K高清壁纸(组图))

一、背景

大家好,我叫孙小空。对于不同的数据,我们采用不同的采集方式,图片、视频、音频、文字都是不同的。由于网站图片素材太多,今天我们采用多线程方式采集一站4K高清壁纸。

二、页面分析

目标网站:

http://www.bizhi88.com/3840x2160/

如图,有278页,这里我们抓取前100页的壁纸图片保存在本地;

解析页面

所有图片都在一个大盒子里,如图所示(

),下面每个div对应一张高清壁纸;

然后是各个页面的div标签中壁纸图片数据的各种信息:1.链接;2. 名称;下面是对xpath的分析;

imgLink = each.xpath("./a[1]/img/@data-original")[0]

name = each.xpath("./a[1]/img/@alt")[0]

有一个注意事项:

图片标签既有src属性,也有data-original属性,都对应图片的url地址。我们一般使用后者,因为data-original-src是自定义属性,图片的实际地址,src属性要求页面完全加载。出现,否则不会得到对应的地址;

三、采集想法

上面说了,图片数据太多,我们不可能写一个for循环来一个一个下载,所以必须使用多线程或者多进程,然后把这么多的数据队列扔给线程用于处理的池或进程池;在python中,multiprocessing Pool 进程池,multiprocessing.dummy 非常好用,

multiprocessing.dummy模块和multiprocessing模块的API是通用的;代码切换更灵活;

页面网址规则:

'http://www.bizhi88.com/s/470/1.html' # 第一页

'http://www.bizhi88.com/s/470/2.html' # 第二页

'http://www.bizhi88.com/s/470/3.html' # 第三页

构造的网址:

page = 'http://www.bizhi88.com/s/470/{}.html'.format(i)

然后我们自定义了两个函数,一个是抓取和解析页面(spider),另一个是下载数据(download),打开线程池,使用for循环构建13个页面的url,存放在list中,作为一个url 队列,使用 **pool.map()** 方法进行爬虫和爬虫操作;

def map(self, fn, *iterables, timeout=None, chunksize=1):

"""Returns an iterator equivalent to map(fn, iter)”“”

这里我们的使用是:pool.map(spider,page) # spider:爬虫函数;page:url队列

功能:提取列表中的每一个元素作为函数的参数,一个一个地创建一个进程,放入进程池中;

参数1:要执行的函数;

参数2:迭代器,将迭代器中的数字作为参数依次传递给函数;

四、Data采集 导入相关第三方库

from lxml import etree # 解析

import requests # 请求

from multiprocessing.dummy import Pool as ThreadPool # 并发

import time # 效率

页面数据分析

def spider(url):

html = requests.get(url, headers=headers)

selector = etree.HTML(html.text)

contents = selector.xpath("//div[@class='flex-img auto mt']/div")

item = {}

for each in contents:

imgLink = each.xpath("./a[1]/img/@data-original")[0]

name = each.xpath("./a[1]/img/@alt")[0]

item['Link'] = imgLink

item['name'] = name

towrite(item)

下载下载图片

def download_pic(contdict):

name = contdict['name']

link = contdict['Link']

with open('img/' + name + '.jpg','wb') as f:

data = requests.get(link)

cont = data.content

f.write(cont)

print('图片' + name + '下载成功!')

main() 主函数

pool = ThreadPool(6)

page = []

for i in range(1, 101):

newpage = 'http://www.bizhi88.com/s/470/{}.html'.format(i)

page.append(newpage)

result = pool.map(spider, page)

pool.close()

pool.join()

说明:在main函数中,我们更喜欢创建六个线程池;通过for循环动态构造100个url;使用map()函数对线程池中的url进行数据解析和存储操作;当线程池关闭时,不关闭线程池只会将状态变为不能再插入元素的状态;五、程序运行

if __name__ == '__main__':

start = time.time() # 开始计时

main()

print(end - start) # 时间差

结果如下:

当然这里只截取了部分图片,一共爬取了2000+张图片。

六、总结

这次我们使用多线程爬取了一张壁纸网站的高清图片。如果我们使用requests,很明显同步请求和下载数据比较慢,所以我们使用多线程的方式下载图片,提高了爬取速度。以效率为例。

php抓取网页所有图片(php抓取网页所有图片,全部保存到data文件中?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 66 次浏览 • 2022-04-08 19:00

php抓取网页所有图片,全部保存到data文件中,用imageio将图片放到linux中,

php目前没有直接支持转换web页面图片大小的库,如果你想放大图片,可以考虑使用tinypng库。

freepic可以批量压缩,

php里面不是有相关的接口吗?php-image这里有几篇博客还有相关的image转换工具介绍:top10html5appstorestfulapistimelinedownloadingphp

newimageio()或者传统方法:爬虫抓取网页时,显示大图放上显示器,浏览器渲染图片加载网页动画到页面。然后,再通过imageio工具根据路径转换图片尺寸,其它浏览器保存图片文件。其实可以采用多媒体文件格式,

phpcorefiltersupdatedonyosemite4.1就可以

php-image

我目前在用的是利用php-image的方法,生成图片转换为gif动画格式,主要是使用的是webp和org.axis.bitmap.svg文件格式,这两个文件格式的特点是转换后图片尺寸大小固定、不会做像素级的变动。那么现在就可以像做一个播放器一样生成自定义尺寸的图片。 查看全部

php抓取网页所有图片(php抓取网页所有图片,全部保存到data文件中?)

php抓取网页所有图片,全部保存到data文件中,用imageio将图片放到linux中,

php目前没有直接支持转换web页面图片大小的库,如果你想放大图片,可以考虑使用tinypng库。

freepic可以批量压缩,

php里面不是有相关的接口吗?php-image这里有几篇博客还有相关的image转换工具介绍:top10html5appstorestfulapistimelinedownloadingphp

newimageio()或者传统方法:爬虫抓取网页时,显示大图放上显示器,浏览器渲染图片加载网页动画到页面。然后,再通过imageio工具根据路径转换图片尺寸,其它浏览器保存图片文件。其实可以采用多媒体文件格式,

phpcorefiltersupdatedonyosemite4.1就可以

php-image

我目前在用的是利用php-image的方法,生成图片转换为gif动画格式,主要是使用的是webp和org.axis.bitmap.svg文件格式,这两个文件格式的特点是转换后图片尺寸大小固定、不会做像素级的变动。那么现在就可以像做一个播放器一样生成自定义尺寸的图片。

php抓取网页所有图片(php抓取网页所有图片的代码,然后php去爬取)

网站优化 • 优采云 发表了文章 • 0 个评论 • 86 次浏览 • 2022-04-04 13:03

php抓取网页所有图片的代码,然后php处理,提取出所有的图片信息,之后存到mysql或者本地。这样是可以的,如果想一次到位的话可以用wordpress的html4j把所有的图片信息都抓取下来,然后php存成数据库,同样也是可以的。

看了你的提问我是知道你是wordpress初学者吧。我是一个wordpress初学者,或者说,我是一个php初学者。其实,与其纠结于这个问题,不如老老实实学一下wordpress。当你的某些功能觉得很难实现的时候,再去挑战任何图片,图片源码处理这种问题。至于功能方面的提升,如果你只是非常大量地抓取图片来干干净净地存放在数据库里,就别太在意算法了。我真心不觉得php程序员需要太多高级的算法。

可以打包成表,让php反爬虫爬虫程序去爬取。

这个问题太简单了,给你一个我最近接触的办法,sitemap3就可以做,数据量太大的话,php直接读png就好,简单便利。反正我刚接触的时候直接去研究stagecolor和linelightingpassage没啥意思。你要对png有足够的认识,才能区分纯色image和touchimage。用多屏截图也可以用imageio不过真是太麻烦了。

这个问题可以类比,我们拿到某图片的img标签后,我们知道它的名字,如jpg。那么我们可以反反爬虫。发现jpg返回2个图片索引,那我们做到前面两个大小一样的图片,大小接近是我们爬虫能力范围内最大的image了,我们就可以到处爬,使用遍历。中途如果改变img的大小,也会更新我们爬虫的索引。require函数也有。当然我觉得这个不是绝对的好,有可能存在imageurl是自己定义的也说不定呢。 查看全部

php抓取网页所有图片(php抓取网页所有图片的代码,然后php去爬取)

php抓取网页所有图片的代码,然后php处理,提取出所有的图片信息,之后存到mysql或者本地。这样是可以的,如果想一次到位的话可以用wordpress的html4j把所有的图片信息都抓取下来,然后php存成数据库,同样也是可以的。

看了你的提问我是知道你是wordpress初学者吧。我是一个wordpress初学者,或者说,我是一个php初学者。其实,与其纠结于这个问题,不如老老实实学一下wordpress。当你的某些功能觉得很难实现的时候,再去挑战任何图片,图片源码处理这种问题。至于功能方面的提升,如果你只是非常大量地抓取图片来干干净净地存放在数据库里,就别太在意算法了。我真心不觉得php程序员需要太多高级的算法。

可以打包成表,让php反爬虫爬虫程序去爬取。

这个问题太简单了,给你一个我最近接触的办法,sitemap3就可以做,数据量太大的话,php直接读png就好,简单便利。反正我刚接触的时候直接去研究stagecolor和linelightingpassage没啥意思。你要对png有足够的认识,才能区分纯色image和touchimage。用多屏截图也可以用imageio不过真是太麻烦了。

这个问题可以类比,我们拿到某图片的img标签后,我们知道它的名字,如jpg。那么我们可以反反爬虫。发现jpg返回2个图片索引,那我们做到前面两个大小一样的图片,大小接近是我们爬虫能力范围内最大的image了,我们就可以到处爬,使用遍历。中途如果改变img的大小,也会更新我们爬虫的索引。require函数也有。当然我觉得这个不是绝对的好,有可能存在imageurl是自己定义的也说不定呢。

php抓取网页所有图片(Web-CTF基础解题必备的知识,注意看隐藏的JavaScript文件)

网站优化 • 优采云 发表了文章 • 0 个评论 • 96 次浏览 • 2022-03-26 06:08

Web-CTF基础解题必备知识1.火狐浏览器F12查看源码

,注意隐藏的JavaScript文件,以及html、base等的编码,必要时解码,检查网络状态判断服务器和网页的状态

2.机器人协议

Robots Protocol(也称为Crawler Protocol、Robot Protocol等)的全称是“Robots Exclusion Protocol”,网站Robots Protocol告诉搜索引擎哪些页面可以爬取,哪些页面可以爬取无法爬行。

关于创建 robots.txt 文件的注意事项:

必须是以txt结尾的纯文本文件;文件名中的所有字母必须小写;文件必须放在网站根目录;放在网站根目录

robots.txt 文件写入:

User-agent: * 这里代表所有搜索引擎类型,是通配符

Disallow: /admin/ 这里的定义是禁止爬取admin目录下的目录

Disallow: /require/ 这里的定义是禁止爬取require目录下的目录

Disallow: /ABC/ 这里的定义是禁止爬取ABC目录下的目录

禁止:/cgi-bin/.htm 禁止访问 /cgi-bin/ 目录中所有以“.htm”为后缀的 URL(包括子目录)。

Disallow: /?* 禁止访问 网站 中收录问号 (?) 的所有 URL

Disallow: /.jpg$ 禁止网页中的所有 .jpg 图片

Disallow:/ab/adc.html 禁止爬取ab文件夹下的adc.html文件。

允许:/cgi-bin/这里的定义是允许cgi-bin目录下的目录被爬取

允许:这里定义/tmp允许爬取tmp的整个目录

允许:.htm$ 只允许访问以“.htm”为后缀的 URL。

允许:.gif$ 允许抓取网页和 gif 文件

Sitemap:网站map 告诉爬虫这个页面是一个网站map

简单地说:allow后面是允许的页面,disallow后面是不允许的页面。

在访问一个网站之前,访问者需要遵守这个协议,哪些文件可以查看,哪些可以爬取,哪些不可以,然后进行下一步。

3.备份

可以备份网络文件。如果文件被删除,可以在url后面输入备份

输入 /xxx.php.bak 下载此备份文件。

4.饼干

什么是 cookie?

事实上,cookies 是由网络服务器存储在您计算机硬盘上的 txt 类型的小文件。它与您的互联网浏览行为有关,因此存储在您计算机上的 cookie 就像您的身份证一样。您计算机上的 Cookie 与其他计算机上的 Cookie 不同; cookie 不能被视为代码执行,也不会成为病毒,因此它们对您几乎无害。

什么是cookie?它有什么作用?

cookies的主要功能是当您访问某些网页并修改网页的某些设置时,cookies可以跟踪和记录这些更改。当您下次访问此网页时,此网页会分析您计算机上的 cookie,进而采取措施,例如将您返回到对您而言更个性化的页面;

当然,目前大部分的广告定位也是基于cookies的。例如,如果您之前访问过很多健身课程网站,cookie 会记录您的访问行为,广告商可以根据您的访问行为,向您发送与健身相关的广告。

打开F12源码,可以查看网络上的cookie,cookie的本质是一个文件,所以可以在url栏中访问cookie文件获取身份信息(或者获取身份信息在源代码)

5.修改网页前端

前端,也称为web前端,是在PC和移动浏览器上运行并展示给用户的网页

最基础的(HTML、CSS、JavaScript)和前端页面开发的核心,对于网站来说,通常是指网站的前端部分,包括表现层网站 和 Structural 层(通俗点是用户能看到的部分)。

综上所述,浏览器、APP、应用的界面呈现和用户交互都是前端。

可以使用bp抓包修改代码

用户可以修改前端代码来改变网站的前端功能。

所以你必须学习一些前端函数和函数代码。

6.编码和转码

在这里插入34;,79&#x:html编码

NTUsNTYsNTQsNzksMTE1L:base64编码

%35%35%2c%35%36%2c%35%34%2c%37%39:URL编码

x/35x/35x/x/35x/36x/2cx/35x/34: javascript编码代码片

将十进制数字或符号转换为这些编码。

另外还可以转换成ASCII编码,对应表如下**:**

7.PHP前端代码8.对于各种网络数据传输,HTTP协议及其web数据操作原理,get,post传输参数...

例如:curl -d b=2 就是使用cmd命令行传递参数,显示服务器端响应。 查看全部

php抓取网页所有图片(Web-CTF基础解题必备的知识,注意看隐藏的JavaScript文件)

Web-CTF基础解题必备知识1.火狐浏览器F12查看源码

,注意隐藏的JavaScript文件,以及html、base等的编码,必要时解码,检查网络状态判断服务器和网页的状态

2.机器人协议

Robots Protocol(也称为Crawler Protocol、Robot Protocol等)的全称是“Robots Exclusion Protocol”,网站Robots Protocol告诉搜索引擎哪些页面可以爬取,哪些页面可以爬取无法爬行。

关于创建 robots.txt 文件的注意事项:

必须是以txt结尾的纯文本文件;文件名中的所有字母必须小写;文件必须放在网站根目录;放在网站根目录

robots.txt 文件写入:

User-agent: * 这里代表所有搜索引擎类型,是通配符

Disallow: /admin/ 这里的定义是禁止爬取admin目录下的目录

Disallow: /require/ 这里的定义是禁止爬取require目录下的目录

Disallow: /ABC/ 这里的定义是禁止爬取ABC目录下的目录

禁止:/cgi-bin/.htm 禁止访问 /cgi-bin/ 目录中所有以“.htm”为后缀的 URL(包括子目录)。

Disallow: /?* 禁止访问 网站 中收录问号 (?) 的所有 URL

Disallow: /.jpg$ 禁止网页中的所有 .jpg 图片

Disallow:/ab/adc.html 禁止爬取ab文件夹下的adc.html文件。

允许:/cgi-bin/这里的定义是允许cgi-bin目录下的目录被爬取

允许:这里定义/tmp允许爬取tmp的整个目录

允许:.htm$ 只允许访问以“.htm”为后缀的 URL。

允许:.gif$ 允许抓取网页和 gif 文件

Sitemap:网站map 告诉爬虫这个页面是一个网站map

简单地说:allow后面是允许的页面,disallow后面是不允许的页面。

在访问一个网站之前,访问者需要遵守这个协议,哪些文件可以查看,哪些可以爬取,哪些不可以,然后进行下一步。

3.备份

可以备份网络文件。如果文件被删除,可以在url后面输入备份

输入 /xxx.php.bak 下载此备份文件。

4.饼干

什么是 cookie?

事实上,cookies 是由网络服务器存储在您计算机硬盘上的 txt 类型的小文件。它与您的互联网浏览行为有关,因此存储在您计算机上的 cookie 就像您的身份证一样。您计算机上的 Cookie 与其他计算机上的 Cookie 不同; cookie 不能被视为代码执行,也不会成为病毒,因此它们对您几乎无害。

什么是cookie?它有什么作用?

cookies的主要功能是当您访问某些网页并修改网页的某些设置时,cookies可以跟踪和记录这些更改。当您下次访问此网页时,此网页会分析您计算机上的 cookie,进而采取措施,例如将您返回到对您而言更个性化的页面;

当然,目前大部分的广告定位也是基于cookies的。例如,如果您之前访问过很多健身课程网站,cookie 会记录您的访问行为,广告商可以根据您的访问行为,向您发送与健身相关的广告。

打开F12源码,可以查看网络上的cookie,cookie的本质是一个文件,所以可以在url栏中访问cookie文件获取身份信息(或者获取身份信息在源代码)

5.修改网页前端

前端,也称为web前端,是在PC和移动浏览器上运行并展示给用户的网页

最基础的(HTML、CSS、JavaScript)和前端页面开发的核心,对于网站来说,通常是指网站的前端部分,包括表现层网站 和 Structural 层(通俗点是用户能看到的部分)。

综上所述,浏览器、APP、应用的界面呈现和用户交互都是前端。

可以使用bp抓包修改代码

用户可以修改前端代码来改变网站的前端功能。

所以你必须学习一些前端函数和函数代码。

6.编码和转码

在这里插入34;,79&#x:html编码

NTUsNTYsNTQsNzksMTE1L:base64编码

%35%35%2c%35%36%2c%35%34%2c%37%39:URL编码

x/35x/35x/x/35x/36x/2cx/35x/34: javascript编码代码片

将十进制数字或符号转换为这些编码。

另外还可以转换成ASCII编码,对应表如下**:**

7.PHP前端代码8.对于各种网络数据传输,HTTP协议及其web数据操作原理,get,post传输参数...

例如:curl -d b=2 就是使用cmd命令行传递参数,显示服务器端响应。

php抓取网页所有图片(搜索引擎公司如何使用网页设计上的”连结方式())

网站优化 • 优采云 发表了文章 • 0 个评论 • 67 次浏览 • 2022-03-25 04:12

1、对世界信息网的抓取和索引就像大城市的地铁系统。

每一个网站都是一个独立的站点(通常是网页的形式,但有时也可以是图片、文档等形式)。并且搜索引擎需要一种方法来“检索”整个 网站 并找到找到每个页面的方法。最好的办法是在网页设计中使用“链接”的方式,不过目前最常用的是网站@网站地图sitemap,这种网站地图可以不定时更新, 无需手动更新, 节省维护时间, 更新网站的内容更费时间, 不定时更新方法请参考“自动更新网站地图站点地图”时间。Sitemap可以快速为搜索引擎蜘蛛提供当前所有页面的路径地址网站,

网站 的链接将所有网页链接在一起。

“网站 上的链接”使搜索引擎机器人(Robots),俗称“网络爬虫”或“网络蜘蛛”,能够在 网站 上抓取大量网络链接。

当搜索引擎找到这些网页并开始检索这些网页时,它会将数据存储在一个庞大的数据库中,通过算法对抓取的网页进行过滤,收录 将符合收录 规则的页面编入索引。,以便搜索用户在搜索后可以看到自己想要的信息。为了让庞大的网络数据即时可用收录,搜索引擎公司必须在全球范围内建立数据中心,以缩短搜索时间。用户在搜索时,都希望立即得到结果,哪怕是1、2秒的延迟都会引起用户的不满,所以搜索引擎公司一直致力于在最短的时间内为用户提供答案。

2、提供搜索和内容展示

搜索引擎可以理解为答录机。当用户在网络搜索引擎上搜索时,搜索引擎在庞大的数据库中做了两件事:

一是通过用户搜索到的关键词,只为用户提供最有用或相关的搜索结果;

其次,通过搜索结果的展示和用户点击浏览的动作,会根据在网站页面的停留时间和热度进行排序,这些搜索的结果也会排名第一和最后.

搜索引擎优化就是影响搜索引擎判断相关性和受欢迎程度的方式。(在网站的构建初期,需要规划好各个关键词的分布,适当的添加到想要优化的文章中)。 查看全部

php抓取网页所有图片(搜索引擎公司如何使用网页设计上的”连结方式())

1、对世界信息网的抓取和索引就像大城市的地铁系统。

每一个网站都是一个独立的站点(通常是网页的形式,但有时也可以是图片、文档等形式)。并且搜索引擎需要一种方法来“检索”整个 网站 并找到找到每个页面的方法。最好的办法是在网页设计中使用“链接”的方式,不过目前最常用的是网站@网站地图sitemap,这种网站地图可以不定时更新, 无需手动更新, 节省维护时间, 更新网站的内容更费时间, 不定时更新方法请参考“自动更新网站地图站点地图”时间。Sitemap可以快速为搜索引擎蜘蛛提供当前所有页面的路径地址网站,

网站 的链接将所有网页链接在一起。

“网站 上的链接”使搜索引擎机器人(Robots),俗称“网络爬虫”或“网络蜘蛛”,能够在 网站 上抓取大量网络链接。

当搜索引擎找到这些网页并开始检索这些网页时,它会将数据存储在一个庞大的数据库中,通过算法对抓取的网页进行过滤,收录 将符合收录 规则的页面编入索引。,以便搜索用户在搜索后可以看到自己想要的信息。为了让庞大的网络数据即时可用收录,搜索引擎公司必须在全球范围内建立数据中心,以缩短搜索时间。用户在搜索时,都希望立即得到结果,哪怕是1、2秒的延迟都会引起用户的不满,所以搜索引擎公司一直致力于在最短的时间内为用户提供答案。

2、提供搜索和内容展示

搜索引擎可以理解为答录机。当用户在网络搜索引擎上搜索时,搜索引擎在庞大的数据库中做了两件事:

一是通过用户搜索到的关键词,只为用户提供最有用或相关的搜索结果;

其次,通过搜索结果的展示和用户点击浏览的动作,会根据在网站页面的停留时间和热度进行排序,这些搜索的结果也会排名第一和最后.

搜索引擎优化就是影响搜索引擎判断相关性和受欢迎程度的方式。(在网站的构建初期,需要规划好各个关键词的分布,适当的添加到想要优化的文章中)。

超值资料:php抓取网页所有图片,放入mysql等数据库,这样不就直接可以从mysql读取图片文件了吗?

网站优化 • 优采云 发表了文章 • 0 个评论 • 120 次浏览 • 2022-09-22 02:06

php抓取网页所有图片,转换成xml文件,放入mysql等数据库,这样不就直接可以从mysql读取图片文件了吗?php你百度或谷歌一下,你就知道。

php一抓一个准,

2014年9月19日php并不容易让人接受,

先把这一句改成另一句试试看

php//注意箭头用逗号分隔;integer_to_float试试看;library("ggplot2")//xml2也试试看;enumerate()也试试看;

php可以抓取网页上的图片,不存在什么抓取速度慢的问题。不过要是想要高效的,你可以考虑python或者php之类的。

php5.3+pdo

php抓取图片的话可以用万彩图表库svgwidget,有接口可以调用。

php有xmlviewapi,用起来像python的requests,连php也有socket了。直接用pdo直接抓,抓完传到mysql再提交过去。当然php本身也有这些api。要看你喜欢什么语言了。

php生成html

让我想起了我刚进大学那会的时候,也是这样子,想从mysql里提取图片。现在互联网应该够火了,好像这些都改用python这种语言了,毕竟有很多python用户,你可以看看。

在centos里面装xcel,启动完直接就可以抓mysql的了,免除了unix的环境切换。 查看全部

超值资料:php抓取网页所有图片,放入mysql等数据库,这样不就直接可以从mysql读取图片文件了吗?

php抓取网页所有图片,转换成xml文件,放入mysql等数据库,这样不就直接可以从mysql读取图片文件了吗?php你百度或谷歌一下,你就知道。

php一抓一个准,

2014年9月19日php并不容易让人接受,

先把这一句改成另一句试试看

php//注意箭头用逗号分隔;integer_to_float试试看;library("ggplot2")//xml2也试试看;enumerate()也试试看;

php可以抓取网页上的图片,不存在什么抓取速度慢的问题。不过要是想要高效的,你可以考虑python或者php之类的。

php5.3+pdo

php抓取图片的话可以用万彩图表库svgwidget,有接口可以调用。

php有xmlviewapi,用起来像python的requests,连php也有socket了。直接用pdo直接抓,抓完传到mysql再提交过去。当然php本身也有这些api。要看你喜欢什么语言了。

php生成html

让我想起了我刚进大学那会的时候,也是这样子,想从mysql里提取图片。现在互联网应该够火了,好像这些都改用python这种语言了,毕竟有很多python用户,你可以看看。

在centos里面装xcel,启动完直接就可以抓mysql的了,免除了unix的环境切换。

你们的百度云不让拿图..(组图)

网站优化 • 优采云 发表了文章 • 0 个评论 • 82 次浏览 • 2022-09-07 02:00

php抓取网页所有图片,图片所有链接,全部存在我的百度云盘上【txt下载链接】"22"->"37"->"35"->"38"->"48"->"57"->"57"【保存到百度云,打开免费mp4】下载百度云+上传图片视频,全部有啦。

你可以试一下adblockplus比网页搜索用什么好多了顺便多说一句...你们的百度云不让拿图...图片能放吗

想必,知乎是用户自己手工设置图片了吧,不像以前的网站。比如,在评论区,会自动加载图片,或者多图。

哎呀,我在考虑要不要说这个不用百度百科的啊,我刚学个一二天,

采用了内嵌入定时器的方法,

上传图片的php的接口有三种:/

已经加载了n多图了,不行,

刚刚好遇到这个问题,不是空的,而是进入对话框,显示说图片太大,要看最近浏览过哪些网页的图片。(百度你太坏了,老是让我上传图片)百度你这是给我设局吗????经过各种折腾,我成功配置成功了上传图片的接口。补充一下接口地址:接口地址:gulp-blocsomeallbacks;filetype=filehttp://%3B.gulpfilename%3D//ch ... name.*+/login/http://;.gulpfilename=//ch/reddit.jpg;/*我只是上传一个web项目,不想配置好无时无刻配置两个地址,这两个ssl认证是很占用系统资源的。求解决方案。*/。 查看全部

你们的百度云不让拿图..(组图)

php抓取网页所有图片,图片所有链接,全部存在我的百度云盘上【txt下载链接】"22"->"37"->"35"->"38"->"48"->"57"->"57"【保存到百度云,打开免费mp4】下载百度云+上传图片视频,全部有啦。

你可以试一下adblockplus比网页搜索用什么好多了顺便多说一句...你们的百度云不让拿图...图片能放吗

想必,知乎是用户自己手工设置图片了吧,不像以前的网站。比如,在评论区,会自动加载图片,或者多图。

哎呀,我在考虑要不要说这个不用百度百科的啊,我刚学个一二天,

采用了内嵌入定时器的方法,

上传图片的php的接口有三种:/

已经加载了n多图了,不行,

刚刚好遇到这个问题,不是空的,而是进入对话框,显示说图片太大,要看最近浏览过哪些网页的图片。(百度你太坏了,老是让我上传图片)百度你这是给我设局吗????经过各种折腾,我成功配置成功了上传图片的接口。补充一下接口地址:接口地址:gulp-blocsomeallbacks;filetype=filehttp://%3B.gulpfilename%3D//ch ... name.*+/login/http://;.gulpfilename=//ch/reddit.jpg;/*我只是上传一个web项目,不想配置好无时无刻配置两个地址,这两个ssl认证是很占用系统资源的。求解决方案。*/。

php抓取网页所有图片信息需要以下这些php代码:--php.exe-phpwind

网站优化 • 优采云 发表了文章 • 0 个评论 • 101 次浏览 • 2022-08-01 15:10

<p>php抓取网页所有图片信息需要以下这些php代码:-php.exe-phpwind.exe-phpserver.exe-php_curl_reader.exe-phpserver.exe-phpconnector.exe-phpclient.exe这里面不包括图片信息。先看看有没有图片信息,要先做下面这几件事:-- 查看全部

php抓取网页所有图片信息需要以下这些php代码:--php.exe-phpwind

<p>php抓取网页所有图片信息需要以下这些php代码:-php.exe-phpwind.exe-phpserver.exe-php_curl_reader.exe-phpserver.exe-phpconnector.exe-phpclient.exe这里面不包括图片信息。先看看有没有图片信息,要先做下面这几件事:--

php安全实验室|php抓取网页所有图片php被封原因

网站优化 • 优采云 发表了文章 • 0 个评论 • 76 次浏览 • 2022-07-30 16:06

php抓取网页所有图片

php被封原因多种多样,有时可能是违反某些政策规定,有时可能是被黑客入侵;这里有一个php安全实验室提供不少帮助:安全实验室|php安全实验室主要方法如下:1.php-login服务器进行观察。2.phptest网站有时会自动拦截php-login的访问,网站php-login主页面可以看到php-loginip地址,ips名称等,但不会显示具体的内容,有些网站的php-login会显示白名单地址,在拦截时会影响到。

也有些网站php-login可以在没有浏览器拦截时,单独显示,但在浏览器对浏览器上php-login地址进行连接时,允许一定长度的过滤。3.yii网站模块性的安全。从不同的角度出发,zendclient、zendframework、zendvirtualframework、blueguard、sysml等等模块可以被安全人员使用,这些模块都会有对应的certbot插件,从而模拟php-login过程,实际上zend安全实验室也会对zendclient的一些权限给予一定的默认值(记得高于500等)。

这里主要是想提醒使用其他安全方法安全人员们,都可以实现php-login的。4.使用metasploit等web和restweb工具。metasploit在php-login过程中,可以拦截邮件,通过webhook命令抓取session、重定向到页面(post用户信息)然后发送给后端,后端收到信息之后,通过设置相应拦截规则进行过滤。

基本上,一般的操作就这么多,当然也有一些可能性,比如网站本身有什么内容,如盗版网站、不安全的链接等,这个好像不存在安全问题,基本的reset就可以弄掉。 查看全部

php安全实验室|php抓取网页所有图片php被封原因

php抓取网页所有图片

php被封原因多种多样,有时可能是违反某些政策规定,有时可能是被黑客入侵;这里有一个php安全实验室提供不少帮助:安全实验室|php安全实验室主要方法如下:1.php-login服务器进行观察。2.phptest网站有时会自动拦截php-login的访问,网站php-login主页面可以看到php-loginip地址,ips名称等,但不会显示具体的内容,有些网站的php-login会显示白名单地址,在拦截时会影响到。