php抓取网页匹配url

php抓取网页匹配url(php抓取网页匹配url中的参数方法if(..))

网站优化 • 优采云 发表了文章 • 0 个评论 • 80 次浏览 • 2021-11-27 14:03

php抓取网页匹配url中的参数方法if(...){try{postmessage({url:":8080/",postid:"aleban",secure:true});}catch(exceptione){e.printstacktrace();}

这个我都会答,关注公众号:python爬虫开发,

换一种post方式,"aleban"是只针对我公众号的,其他不受影响。

把你想访问的页面用抓包工具抓包,

提供几个思路:

1、运行爬虫,得到domcookie,这个一般是浏览器抓包工具才有,比如postman,对于部分库来说并不适用。抓取的数据要进行保存和处理,比如设置时间戳发送等等。

2、可以把抓取的数据,像json、html等格式转换成javascript代码,如gson、webdriver、mathjax等。

3、对于某些固定url,可以定期抓取,使用beautifulsoup等模块直接拿到数据。

带参数的url,使用preparedefined方法。

爬虫的一般解决方法

现在我发现一个非常强大的工具threejs,本地就可以爬取各种网站的特定页面:

awesomepythonwebscrapingwithpreparedefinedurls

1.使用相关库,

urllib2,requests 查看全部

php抓取网页匹配url(php抓取网页匹配url中的参数方法if(..))

php抓取网页匹配url中的参数方法if(...){try{postmessage({url:":8080/",postid:"aleban",secure:true});}catch(exceptione){e.printstacktrace();}

这个我都会答,关注公众号:python爬虫开发,

换一种post方式,"aleban"是只针对我公众号的,其他不受影响。

把你想访问的页面用抓包工具抓包,

提供几个思路:

1、运行爬虫,得到domcookie,这个一般是浏览器抓包工具才有,比如postman,对于部分库来说并不适用。抓取的数据要进行保存和处理,比如设置时间戳发送等等。

2、可以把抓取的数据,像json、html等格式转换成javascript代码,如gson、webdriver、mathjax等。

3、对于某些固定url,可以定期抓取,使用beautifulsoup等模块直接拿到数据。

带参数的url,使用preparedefined方法。

爬虫的一般解决方法

现在我发现一个非常强大的工具threejs,本地就可以爬取各种网站的特定页面:

awesomepythonwebscrapingwithpreparedefinedurls

1.使用相关库,

urllib2,requests

php抓取网页匹配url(最佳答案,正则匹配部分新闻内容存入数组,该怎么做呢?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 70 次浏览 • 2021-11-24 13:10

最佳答案

我是php新手,现在想用c***l抓取学校网页,把新闻内容的正则匹配部分存放在数组中。我该怎么办?以下为官网部分主要代码。我想在开始时抓取内容。可以通过常规匹配来实现吗?再问一下,PHP的正则匹配是用PCRE实现的还是什么的?网上这部分的知识好乱,求大神

首先c***l不是这样使用的,需要先初始化c***l_init,然后需要使用c***l_setopt来设置你请求的参数和设置。最后通过c***l_exec执行请求。

返回的结果必须是网页的完整源代码。如果要从中提取信息,就得看好目标位置是否有唯一标识,也就是能否准确定位到自己需要的位置。然后使用正则匹配。你上面只给了一个td。如果确实可以保证这个 td(加上它的属性)是你想要的数据,那么它可以是正则的。

这很简单

/

]+>(.*)/

跟进:

非常满意。你能解释一下这个符号的含义吗?另外,我看到已经匹配并存储了一个数组,但我看不到它。请问如何再次输出。

回复:

/ 的左右两边是分隔的,不需要解释。[^>] 是匹配除 > 之外的任何字符。+ 是匹配前面括号的内容一次或多次。(.*) 匹配任意数量的字符。当然,你可能需要改成(.*?)来实现非贪婪匹配,即匹配到最近的时

在时间停止当前匹配以继续下一轮匹配(因为您正在使用 match_all 函数)。括号表示分组,所以这个分组会记录在列表结果中,$list[1]就是这个分组的数据。 查看全部

php抓取网页匹配url(最佳答案,正则匹配部分新闻内容存入数组,该怎么做呢?)

最佳答案

我是php新手,现在想用c***l抓取学校网页,把新闻内容的正则匹配部分存放在数组中。我该怎么办?以下为官网部分主要代码。我想在开始时抓取内容。可以通过常规匹配来实现吗?再问一下,PHP的正则匹配是用PCRE实现的还是什么的?网上这部分的知识好乱,求大神

首先c***l不是这样使用的,需要先初始化c***l_init,然后需要使用c***l_setopt来设置你请求的参数和设置。最后通过c***l_exec执行请求。

返回的结果必须是网页的完整源代码。如果要从中提取信息,就得看好目标位置是否有唯一标识,也就是能否准确定位到自己需要的位置。然后使用正则匹配。你上面只给了一个td。如果确实可以保证这个 td(加上它的属性)是你想要的数据,那么它可以是正则的。

这很简单

/

]+>(.*)/

跟进:

非常满意。你能解释一下这个符号的含义吗?另外,我看到已经匹配并存储了一个数组,但我看不到它。请问如何再次输出。

回复:

/ 的左右两边是分隔的,不需要解释。[^>] 是匹配除 > 之外的任何字符。+ 是匹配前面括号的内容一次或多次。(.*) 匹配任意数量的字符。当然,你可能需要改成(.*?)来实现非贪婪匹配,即匹配到最近的时

在时间停止当前匹配以继续下一轮匹配(因为您正在使用 match_all 函数)。括号表示分组,所以这个分组会记录在列表结果中,$list[1]就是这个分组的数据。

php抓取网页匹配url(php抓取网页匹配url等缓存系统缓存用户缓存机制在哪个时间点有用访问量修改虚拟内存可以修改对象可以基于泛型)

网站优化 • 优采云 发表了文章 • 0 个评论 • 73 次浏览 • 2021-11-23 19:04

php抓取网页匹配url抓取网页内容redisd等缓存系统缓存用户缓存机制在哪个时间点有用访问量修改虚拟内存可以修改对象可以基于泛型使用getter/setter方法来定制时序。html/css等不推荐使用全局变量限制sql语句范围小型系统一个提示图。nodejs本身是可以用co,redisd等缓存系统作为宿主。

你可以选择一个你感兴趣的。php可以使用getsavemessage,redisd可以使用ci工作并且使用redisd代码可以直接拿出来部署。

用php一直在琢磨bootstrap。对于初学者,mvc的使用会是遇到的最多的问题之一。然后还可以看下thinkphp,写过一些感觉效果还不错。

可以用php构建微型系统,php-fpm或erlang-fi。即嵌入工具,在客户端,只要是可以达到php语言规范的语言语法,在服务端,完全符合erlang语言规范。这两种语言在php中都已经被大量使用,而且自己没有readability,tree等限制。

我觉得想要拿好工资就去拼linux开发,还有phplinux环境等等,去创业公司,

cs与bios无缝嵌入;学会虚拟机可以开发类似runtime模拟windows。说直白点,就是找到超级简单的中间层,

找个自己真正感兴趣的点, 查看全部

php抓取网页匹配url(php抓取网页匹配url等缓存系统缓存用户缓存机制在哪个时间点有用访问量修改虚拟内存可以修改对象可以基于泛型)

php抓取网页匹配url抓取网页内容redisd等缓存系统缓存用户缓存机制在哪个时间点有用访问量修改虚拟内存可以修改对象可以基于泛型使用getter/setter方法来定制时序。html/css等不推荐使用全局变量限制sql语句范围小型系统一个提示图。nodejs本身是可以用co,redisd等缓存系统作为宿主。

你可以选择一个你感兴趣的。php可以使用getsavemessage,redisd可以使用ci工作并且使用redisd代码可以直接拿出来部署。

用php一直在琢磨bootstrap。对于初学者,mvc的使用会是遇到的最多的问题之一。然后还可以看下thinkphp,写过一些感觉效果还不错。

可以用php构建微型系统,php-fpm或erlang-fi。即嵌入工具,在客户端,只要是可以达到php语言规范的语言语法,在服务端,完全符合erlang语言规范。这两种语言在php中都已经被大量使用,而且自己没有readability,tree等限制。

我觉得想要拿好工资就去拼linux开发,还有phplinux环境等等,去创业公司,

cs与bios无缝嵌入;学会虚拟机可以开发类似runtime模拟windows。说直白点,就是找到超级简单的中间层,

找个自己真正感兴趣的点,

php抓取网页匹配url(PythonDjangoDjango应用投票)

网站优化 • 优采云 发表了文章 • 0 个评论 • 89 次浏览 • 2021-11-18 23:18

编写您的第一个 Django 应用程序,第 1 部分

让我们以身作则。

通过本教程,我们将带您创建一个基本的投票应用程序。

它将由两部分组成:

我们假设您已经阅读了有关安装 Django 的内容。在命令提示符下输入命令(以$为前缀)就可以知道Django已经安装完毕以及安装的是哪个版本。

$ python -m django --version

...\> py -m django --version

如果这行命令输出一个版本号,则证明你已经安装了这个版本的Django;如果您收到“No module named django”错误消息,则表示您尚未安装它。

本教程是为 Django 3.2 编写的,支持 Python 3.6 及后续版本。如果Django版本不匹配,您可以通过页面右下角的版本切换器切换到您版本对应的教程,或者更新到最新版本。如果您使用的是旧版本的 Python,请寻找合适的 Django 版本。

您可以查看文档 How to Install Django 以获取删除旧版本和安装新版本的过程和建议。

从哪里获得帮助:

如果您在阅读本教程时有任何疑问,可以转到常见问题部分寻求帮助。

创建项目

如果这是您第一次使用 Django,则需要一些初始设置。换句话说,你需要用一些自动生成的代码来配置一个 Django——即一个 Django 项目实例所需的设置集合,包括数据库配置、Django 配置和应用程序配置。

打开命令行,cd 到要放置代码的目录,然后运行以下命令:

$ django-admin startproject mysite

...\> django-admin startproject mysite

这行代码将在当前目录中创建一个 mysite 目录。如果命令失败,请检查它,它可能会帮助您。

注解

您必须避免使用 Python 或 Django 的内部保留字来命名您的项目。具体来说,您必须避免使用 django(与 Django 本身冲突)或 test(与 Python 的内置组件冲突)之类的名称。

我应该把代码放在哪里?

如果您曾经是 PHP 原生程序员(从未使用过现代框架),您可能习惯于将代码放在 Web 服务器的文档根目录中(例如 /var/www)。这在使用 Django 时不是必需的。将所有 Python 代码放在 Web 服务器的根目录中并不是一个好主意,因为它有风险。例如,它会增加人们在 网站 上看到您的代码的可能性。这不利于网站的安全。

将您的代码放在文档根目录以外的其他位置,例如 /home/mycode。

让我们看看创建了什么:

mysite/

manage.py

mysite/

__init__.py

settings.py

urls.py

asgi.py

wsgi.py

这些目录和文件的用处是:

用于开发的简单服务器

我们来确认一下你的Django项目是否真的创建成功。如果当前目录不是mysite外目录,请切换到该目录,然后运行以下命令:

$ python manage.py runserver

...\> py manage.py runserver

您应该看到以下输出:

Performing system checks...

System check identified no issues (0 silenced).

You have unapplied migrations; your app may not work properly until they are applied.

Run 'python manage.py migrate' to apply them.

十一月 18, 2021 - 15:50:53

Django version 3.2, using settings 'mysite.settings'

Starting development server at http://127.0.0.1:8000/

Quit the server with CONTROL-C.

注解

忽略不应用最新数据库迁移的警告,我们稍后会处理数据库。

你刚刚开始的是Django自带的用于开发的简单服务器。它是一个用纯 Python 编写的轻量级 Web 服务器。我们将这个服务器内置到 Django 中,以便您可以快速开发您想要的东西,因为您不需要配置生产级服务器(例如 Apache),除非您准备将其放入生产环境。

现在是提醒您的好时机:切勿在任何与生产环境相关的地方使用此服务器。此服务器仅用于开发。(我们是网络框架方面的专家,但不是网络服务器方面的专家。)

现在,服务器正在运行,浏览器访问:8000/。您将看到一个“祝贺”页面,并且随着火箭发射,服务器已经在运行。

更换端口

默认情况下,该命令会将服务器设置为侦听机器内部 IP 的 8000 端口。

如果要更改服务器的监听端口,请使用命令行参数。例如,以下命令将使服务器侦听端口 8080:

$ python manage.py runserver 8080

...\> py manage.py runserver 8080

如果要更改服务器侦听的IP,请在端口前输入新的IP。例如,为了监控所有服务器的公共 IP(这在您运行 Vagrant 或想要向网络上的其他计算机显示您的结果时很有用),请使用:

$ python manage.py runserver 0:8000

...\> py manage.py runserver 0:8000

0 是 0.0.0.0 的缩写。可以在参考文档中找到有关开发服务器的完整文档。

一个会自动重新加载的服务器

如果需要,用于开发的服务器将为每个访问请求重新加载 Python 代码。因此,您无需频繁重启服务器即可使修改后的代码生效。但是,某些操作(例如添加新文件)不会触发自动重新加载,在这种情况下您必须手动重新启动服务器。

创建投票应用

现在你的开发环境——这个“项目”——已经配置好了,你可以开始工作了。

在 Django 中,每个应用程序都是一个 Python 包并遵循相同的约定。Django 附带了一个工具,可以帮助您生成应用程序的基本目录结构,因此您可以专注于编写代码而不是创建目录。

项目 VS 应用

项目和应用程序有什么区别?应用程序是专门用于执行某些操作的 Web 应用程序,例如博客系统、公共记录数据库或小型投票程序。该项目是 网站 使用的配置和应用程序的集合。该项目可以收录许多应用程序。该应用程序可用于许多项目。

您的应用程序可以存储在定义的任何路径中。在本教程中,我们将在与您的 manage.py 相同的目录中创建一个投票应用程序。通过这种方式,它可以作为顶级模块而不是 mysite 的子模块导入。

确保您与 manage.py 位于同一目录中,然后运行此命令以创建应用程序:

$ python manage.py startapp polls

...\> py manage.py startapp polls

这将创建一个 polls 目录,其目录结构大致如下:

polls/

__init__.py

admin.py

apps.py

migrations/

__init__.py

models.py

tests.py

views.py

此目录结构收录投票应用程序的所有内容。

写第一个视图

让我们开始编写第一个视图。打开 polls/views.py 并输入以下 Python 代码:

民意调查/views.py

from django.http import HttpResponse

def index(request):

return HttpResponse("Hello, world. You're at the polls index.")

这是 Django 中最简单的视图。如果我们想看到效果,我们需要将一个 URL 映射到它——这就是我们需要 URLconf 的原因。

为了创建 URLconf,请在 polls 目录中创建一个新的 urls.py 文件。您的应用程序目录现在应如下所示:

polls/

__init__.py

admin.py

apps.py

migrations/

__init__.py

models.py

tests.py

urls.py

views.py

在 polls/urls.py 中,输入以下代码:

民意调查/网址.py

from django.urls import path

from . import views

urlpatterns = [

path('', views.index, name='index'),

]

下一步是指定我们在根 URLconf 文件中创建的 polls.urls 模块。在mysite/urls.py文件的urlpatterns列表中插入一个include(),如下:

我的网站/urls.py

from django.contrib import admin

from django.urls import include, path

urlpatterns = [

path('polls/', include('polls.urls')),

path('admin/', admin.site.urls),

]

该函数允许引用其他 URLconf。每当 Django 遇到它时,它都会截断 URL 中与此项匹配的部分,并将剩余的字符串发送到 URLconf 以进行进一步处理。

我们的设计理念是即插即用。因为投票应用程序有自己的 URLconf (polls/urls.py),它们可以放置在“/polls/”、“/fun_polls/”、“/content/polls/”或任何其他路径中。可以正常工作。

何时使用

在收录其他 URL 模式时,您应该始终使用 include(),admin.site.urls 是唯一的例外。

您现在已将索引视图添加到 URLconf。使用以下命令验证它是否正常工作:

$ python manage.py runserver

...\> py manage.py runserver

使用浏览器访问:8000/polls/,应该可以看到“Hello, world. You're at the polls index.”,在index视图中定义。

没有找到页面?

如果您在此处看到错误页面,请检查您是否正在访问 :8000/polls/ 而不是 :8000/。

该函数有四个参数,两个必需参数:route 和 view,以及两个可选参数:kwargs 和 name。现在,是时候研究这些参数的含义了。

参数:路由

route 是匹配 URL 的标准(类似于正则表达式)。当 Django 响应请求时,它会从 urlpatterns 的第一项开始,依次匹配列表中的项,直到找到匹配项。

这些条件将不匹配 GET 和 POST 参数或域名。例如,当 URLconf 处理请求时,它会尝试匹配 myapp/。在处理请求时,它只会尝试匹配 myapp/。

参数:查看

当 Django 找到匹配条件时,它会调用这个特定的视图函数并传入一个对象作为第一个参数。“捕获的”参数作为关键字参数传入。我们稍后会举一个例子。

参数:kwargs

可以将任意数量的关键字参数作为字典传递给目标视图函数。本教程将不使用此功能。

参数:名称

命名你的 URL 允许你在 Django 的任何地方唯一地引用它,尤其是在模板中。这一有用的功能允许您通过仅更改一个文件来全局修改 URL 模式。

在您了解基本的请求和响应过程后,请阅读教程的第 2 部分以开始使用数据库。 查看全部

php抓取网页匹配url(PythonDjangoDjango应用投票)

编写您的第一个 Django 应用程序,第 1 部分

让我们以身作则。

通过本教程,我们将带您创建一个基本的投票应用程序。

它将由两部分组成:

我们假设您已经阅读了有关安装 Django 的内容。在命令提示符下输入命令(以$为前缀)就可以知道Django已经安装完毕以及安装的是哪个版本。

$ python -m django --version

...\> py -m django --version

如果这行命令输出一个版本号,则证明你已经安装了这个版本的Django;如果您收到“No module named django”错误消息,则表示您尚未安装它。

本教程是为 Django 3.2 编写的,支持 Python 3.6 及后续版本。如果Django版本不匹配,您可以通过页面右下角的版本切换器切换到您版本对应的教程,或者更新到最新版本。如果您使用的是旧版本的 Python,请寻找合适的 Django 版本。

您可以查看文档 How to Install Django 以获取删除旧版本和安装新版本的过程和建议。

从哪里获得帮助:

如果您在阅读本教程时有任何疑问,可以转到常见问题部分寻求帮助。

创建项目

如果这是您第一次使用 Django,则需要一些初始设置。换句话说,你需要用一些自动生成的代码来配置一个 Django——即一个 Django 项目实例所需的设置集合,包括数据库配置、Django 配置和应用程序配置。

打开命令行,cd 到要放置代码的目录,然后运行以下命令:

$ django-admin startproject mysite

...\> django-admin startproject mysite

这行代码将在当前目录中创建一个 mysite 目录。如果命令失败,请检查它,它可能会帮助您。

注解

您必须避免使用 Python 或 Django 的内部保留字来命名您的项目。具体来说,您必须避免使用 django(与 Django 本身冲突)或 test(与 Python 的内置组件冲突)之类的名称。

我应该把代码放在哪里?

如果您曾经是 PHP 原生程序员(从未使用过现代框架),您可能习惯于将代码放在 Web 服务器的文档根目录中(例如 /var/www)。这在使用 Django 时不是必需的。将所有 Python 代码放在 Web 服务器的根目录中并不是一个好主意,因为它有风险。例如,它会增加人们在 网站 上看到您的代码的可能性。这不利于网站的安全。

将您的代码放在文档根目录以外的其他位置,例如 /home/mycode。

让我们看看创建了什么:

mysite/

manage.py

mysite/

__init__.py

settings.py

urls.py

asgi.py

wsgi.py

这些目录和文件的用处是:

用于开发的简单服务器

我们来确认一下你的Django项目是否真的创建成功。如果当前目录不是mysite外目录,请切换到该目录,然后运行以下命令:

$ python manage.py runserver

...\> py manage.py runserver

您应该看到以下输出:

Performing system checks...

System check identified no issues (0 silenced).

You have unapplied migrations; your app may not work properly until they are applied.

Run 'python manage.py migrate' to apply them.

十一月 18, 2021 - 15:50:53

Django version 3.2, using settings 'mysite.settings'

Starting development server at http://127.0.0.1:8000/

Quit the server with CONTROL-C.

注解

忽略不应用最新数据库迁移的警告,我们稍后会处理数据库。

你刚刚开始的是Django自带的用于开发的简单服务器。它是一个用纯 Python 编写的轻量级 Web 服务器。我们将这个服务器内置到 Django 中,以便您可以快速开发您想要的东西,因为您不需要配置生产级服务器(例如 Apache),除非您准备将其放入生产环境。

现在是提醒您的好时机:切勿在任何与生产环境相关的地方使用此服务器。此服务器仅用于开发。(我们是网络框架方面的专家,但不是网络服务器方面的专家。)

现在,服务器正在运行,浏览器访问:8000/。您将看到一个“祝贺”页面,并且随着火箭发射,服务器已经在运行。

更换端口

默认情况下,该命令会将服务器设置为侦听机器内部 IP 的 8000 端口。

如果要更改服务器的监听端口,请使用命令行参数。例如,以下命令将使服务器侦听端口 8080:

$ python manage.py runserver 8080

...\> py manage.py runserver 8080

如果要更改服务器侦听的IP,请在端口前输入新的IP。例如,为了监控所有服务器的公共 IP(这在您运行 Vagrant 或想要向网络上的其他计算机显示您的结果时很有用),请使用:

$ python manage.py runserver 0:8000

...\> py manage.py runserver 0:8000

0 是 0.0.0.0 的缩写。可以在参考文档中找到有关开发服务器的完整文档。

一个会自动重新加载的服务器

如果需要,用于开发的服务器将为每个访问请求重新加载 Python 代码。因此,您无需频繁重启服务器即可使修改后的代码生效。但是,某些操作(例如添加新文件)不会触发自动重新加载,在这种情况下您必须手动重新启动服务器。

创建投票应用

现在你的开发环境——这个“项目”——已经配置好了,你可以开始工作了。

在 Django 中,每个应用程序都是一个 Python 包并遵循相同的约定。Django 附带了一个工具,可以帮助您生成应用程序的基本目录结构,因此您可以专注于编写代码而不是创建目录。

项目 VS 应用

项目和应用程序有什么区别?应用程序是专门用于执行某些操作的 Web 应用程序,例如博客系统、公共记录数据库或小型投票程序。该项目是 网站 使用的配置和应用程序的集合。该项目可以收录许多应用程序。该应用程序可用于许多项目。

您的应用程序可以存储在定义的任何路径中。在本教程中,我们将在与您的 manage.py 相同的目录中创建一个投票应用程序。通过这种方式,它可以作为顶级模块而不是 mysite 的子模块导入。

确保您与 manage.py 位于同一目录中,然后运行此命令以创建应用程序:

$ python manage.py startapp polls

...\> py manage.py startapp polls

这将创建一个 polls 目录,其目录结构大致如下:

polls/

__init__.py

admin.py

apps.py

migrations/

__init__.py

models.py

tests.py

views.py

此目录结构收录投票应用程序的所有内容。

写第一个视图

让我们开始编写第一个视图。打开 polls/views.py 并输入以下 Python 代码:

民意调查/views.py

from django.http import HttpResponse

def index(request):

return HttpResponse("Hello, world. You're at the polls index.")

这是 Django 中最简单的视图。如果我们想看到效果,我们需要将一个 URL 映射到它——这就是我们需要 URLconf 的原因。

为了创建 URLconf,请在 polls 目录中创建一个新的 urls.py 文件。您的应用程序目录现在应如下所示:

polls/

__init__.py

admin.py

apps.py

migrations/

__init__.py

models.py

tests.py

urls.py

views.py

在 polls/urls.py 中,输入以下代码:

民意调查/网址.py

from django.urls import path

from . import views

urlpatterns = [

path('', views.index, name='index'),

]

下一步是指定我们在根 URLconf 文件中创建的 polls.urls 模块。在mysite/urls.py文件的urlpatterns列表中插入一个include(),如下:

我的网站/urls.py

from django.contrib import admin

from django.urls import include, path

urlpatterns = [

path('polls/', include('polls.urls')),

path('admin/', admin.site.urls),

]

该函数允许引用其他 URLconf。每当 Django 遇到它时,它都会截断 URL 中与此项匹配的部分,并将剩余的字符串发送到 URLconf 以进行进一步处理。

我们的设计理念是即插即用。因为投票应用程序有自己的 URLconf (polls/urls.py),它们可以放置在“/polls/”、“/fun_polls/”、“/content/polls/”或任何其他路径中。可以正常工作。

何时使用

在收录其他 URL 模式时,您应该始终使用 include(),admin.site.urls 是唯一的例外。

您现在已将索引视图添加到 URLconf。使用以下命令验证它是否正常工作:

$ python manage.py runserver

...\> py manage.py runserver

使用浏览器访问:8000/polls/,应该可以看到“Hello, world. You're at the polls index.”,在index视图中定义。

没有找到页面?

如果您在此处看到错误页面,请检查您是否正在访问 :8000/polls/ 而不是 :8000/。

该函数有四个参数,两个必需参数:route 和 view,以及两个可选参数:kwargs 和 name。现在,是时候研究这些参数的含义了。

参数:路由

route 是匹配 URL 的标准(类似于正则表达式)。当 Django 响应请求时,它会从 urlpatterns 的第一项开始,依次匹配列表中的项,直到找到匹配项。

这些条件将不匹配 GET 和 POST 参数或域名。例如,当 URLconf 处理请求时,它会尝试匹配 myapp/。在处理请求时,它只会尝试匹配 myapp/。

参数:查看

当 Django 找到匹配条件时,它会调用这个特定的视图函数并传入一个对象作为第一个参数。“捕获的”参数作为关键字参数传入。我们稍后会举一个例子。

参数:kwargs

可以将任意数量的关键字参数作为字典传递给目标视图函数。本教程将不使用此功能。

参数:名称

命名你的 URL 允许你在 Django 的任何地方唯一地引用它,尤其是在模板中。这一有用的功能允许您通过仅更改一个文件来全局修改 URL 模式。

在您了解基本的请求和响应过程后,请阅读教程的第 2 部分以开始使用数据库。

php抓取网页匹配url(循环读取流中的每一行字符,取得email的详细内容)

网站优化 • 优采云 发表了文章 • 0 个评论 • 90 次浏览 • 2021-11-18 10:01

4、 循环读取流中的每一行数据,Pattern 对象编译的正则表达式匹配每一行字符,获取邮件地址

这是我们的代码:

package cn.bdqn; import java.io.BufferedReader; import java.io.IOException; import java.io.InputStreamReader; //和网络相关的操作 import java.net.URL; import java.net.URLConnection; import java.util.regex.Matcher; import java.util.regex.Pattern; /** * 正则抓取邮箱 * @author happy * */ public class Test { public static void main(String[] args) throws IOException { //1.1 创建一个url对象 URL url = new URL("https://www.douban.com/group/topic/8845032/"); //1.2 打开连接 URLConnection conn = url.openConnection(); //1.3 设置连接网络超时时间 单位为毫秒 conn.setConnectTimeout(1000 * 10); //1.4 通过流 操作读取指定网络地址中的文件 BufferedReader bufr = new BufferedReader(new InputStreamReader(conn.getInputStream())); String line = null; //1.5 匹配email的正则 String regex = "[a-zA-Z0-9_-]+@\\w+\\.[a-z]+(\\.[a-z]+)?"; //1.6 使用模式的compile()方法生成模式对象 Pattern p = Pattern.compile(regex); //1. while((line = bufr.readLine()) != null) { Matcher m = p.matcher(line); while(m.find()) { System.out.println(m.group());// 获得匹配的email } } } }

这里主要是使用正则来匹配邮箱:

字符串正则表达式 = "[a-zA-Z0-9_-]+@\\w+\\.[az]+(\\.[az]+)?";

[a-zA-Z0-9_-] 只能收录字母、数字、下划线和减号。“+”表示匹配 [a-zA-Z0-9_-] 一次或多次。@后面可以出现任何非单字符,相当于[^a-zA-Z0-9_],可以重复一次或多次,结束后必须有\。被转义,然后点击后,可以出现a和z之间的任何字符。

捕获的结果如下:

以上就是java使用正则抓取webmail的详细内容,请关注其他相关html中文网站文章! 查看全部

php抓取网页匹配url(循环读取流中的每一行字符,取得email的详细内容)

4、 循环读取流中的每一行数据,Pattern 对象编译的正则表达式匹配每一行字符,获取邮件地址

这是我们的代码:

package cn.bdqn; import java.io.BufferedReader; import java.io.IOException; import java.io.InputStreamReader; //和网络相关的操作 import java.net.URL; import java.net.URLConnection; import java.util.regex.Matcher; import java.util.regex.Pattern; /** * 正则抓取邮箱 * @author happy * */ public class Test { public static void main(String[] args) throws IOException { //1.1 创建一个url对象 URL url = new URL("https://www.douban.com/group/topic/8845032/";); //1.2 打开连接 URLConnection conn = url.openConnection(); //1.3 设置连接网络超时时间 单位为毫秒 conn.setConnectTimeout(1000 * 10); //1.4 通过流 操作读取指定网络地址中的文件 BufferedReader bufr = new BufferedReader(new InputStreamReader(conn.getInputStream())); String line = null; //1.5 匹配email的正则 String regex = "[a-zA-Z0-9_-]+@\\w+\\.[a-z]+(\\.[a-z]+)?"; //1.6 使用模式的compile()方法生成模式对象 Pattern p = Pattern.compile(regex); //1. while((line = bufr.readLine()) != null) { Matcher m = p.matcher(line); while(m.find()) { System.out.println(m.group());// 获得匹配的email } } } }

这里主要是使用正则来匹配邮箱:

字符串正则表达式 = "[a-zA-Z0-9_-]+@\\w+\\.[az]+(\\.[az]+)?";

[a-zA-Z0-9_-] 只能收录字母、数字、下划线和减号。“+”表示匹配 [a-zA-Z0-9_-] 一次或多次。@后面可以出现任何非单字符,相当于[^a-zA-Z0-9_],可以重复一次或多次,结束后必须有\。被转义,然后点击后,可以出现a和z之间的任何字符。

捕获的结果如下:

以上就是java使用正则抓取webmail的详细内容,请关注其他相关html中文网站文章!

php抓取网页匹配url( 一下格式文件介绍一下模块中的几个简单功能(图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 78 次浏览 • 2021-11-18 09:21

一下格式文件介绍一下模块中的几个简单功能(图))

Python使用re正则表达式抢豆瓣电影Top250排名

使用 request 和 re 获取电影名称、电影年份、电影评分和电影排名的评论人数,并将它们写为 .csv 文件

先介绍一下re模块中的几个简单常用的方法

重新模块

几个简单的功能

1. findall

# findall :匹配字符串中所有符合正则的内容

import re

result = re.findall(r"\d+", "你好我的电话是123456,他的电话是654321")

print(result)

>>>['123456', '654321']

2. 查找器

# finditer :匹配字符串中所有的内容(返回迭代器)

result2 = re.finditer(r"\d+", "你好我的电话是123456,他的电话是654321")

for i in result2:#从迭代器中取数据

print(i)

>>>

>>>

for i in result2:#从迭代器中取数据

print(i.group()) #使用group()方法直接输出match到的数据

>>>123456

>>>654321

3.搜索

#search 只要找到一个结果就返回match对象,需要使用group()方法取数据

result3 = re.search(r"\d+", "你好我的电话是123456,他的电话是654321")

print(result3.group())

>>>123456

print(result3.group())

>>>123456#不会继续往后找

4.匹配

#match 从头开始匹配,相当于默认在正则表达式前面加了"^"

result3 = re.match(r"\d+", "你好我的电话是123456,他的电话是654321")

print(result3.group()) #报错,数据为空

5.预加载正则表达式

当一个正则表达式需要多次使用时,为了提高执行效率,可以预加载正则表达式。

#预加载正则表达式

obj = re.compile(r"正则表达式")

#使用方式

result = obj.finditer("你好我的电话是123456,他的电话是654321")

for i in result2:#从迭代器中取数据

print(i.group()) #使用group()方法直接输出match到的数据

步

获取页面源码——>requests

通过re和正则化提取有效信息——>re

代码

import requests #导入请求包

import re #正则

url = "https://movie.douban.com/top250"

#添加User-Agent

headers = {

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36"

}

resp = requests.get(url, headers=headers) #获取响应数据

page_content = resp.text #提取源代码

#解析数据

obj = re.compile(r'.*?.*?(?P.*?).*?<p class="">.*?

.*?(?P.*?) .*?(?P.*?).*?(?P.*?)人评价', re.S) #书写正则表达式(关键在于寻找定位标签)

result = obj.finditer(page_content)#利用正则来提取数据,将电影名称存放在name组,年份存在year组,评分存在score组,评价人数存在people组(返回迭代器)

for i in result:

print(i.group("name"))

print(i.group("year").strip())#去除year的多余空格

print(i.group("score"))

print(i.group("people"))

print("Over!")

提升

在上面的例子中,我们抓取了本页的数据,但无法获取下一页的数据。观察下一页的网址,发现跳转的页数其实是url中某个参数的变化,而且是有规律的变化。本例中,第二页的网址为“”,第三页的网址为“”。即start=后面的参数改变,每跳转一个页面,参数加25.

然后我们可以将参数设置为一个变量,在获取到每一页后将其值加25,然后跳转到下一页。接下来以爬取10页为例,将数据写入.csv格式文件

<p>import requests #导入请求包

import re #正则

import csv #导入scv模块用于数据读写

index = 0 #页面跳转参数

f = open("data.csv", mode="a", newline='') #新建并打开名为data.csv的文件用于写入数据

while index 查看全部

php抓取网页匹配url(

一下格式文件介绍一下模块中的几个简单功能(图))

Python使用re正则表达式抢豆瓣电影Top250排名

使用 request 和 re 获取电影名称、电影年份、电影评分和电影排名的评论人数,并将它们写为 .csv 文件

先介绍一下re模块中的几个简单常用的方法

重新模块

几个简单的功能

1. findall

# findall :匹配字符串中所有符合正则的内容

import re

result = re.findall(r"\d+", "你好我的电话是123456,他的电话是654321")

print(result)

>>>['123456', '654321']

2. 查找器

# finditer :匹配字符串中所有的内容(返回迭代器)

result2 = re.finditer(r"\d+", "你好我的电话是123456,他的电话是654321")

for i in result2:#从迭代器中取数据

print(i)

>>>

>>>

for i in result2:#从迭代器中取数据

print(i.group()) #使用group()方法直接输出match到的数据

>>>123456

>>>654321

3.搜索

#search 只要找到一个结果就返回match对象,需要使用group()方法取数据

result3 = re.search(r"\d+", "你好我的电话是123456,他的电话是654321")

print(result3.group())

>>>123456

print(result3.group())

>>>123456#不会继续往后找

4.匹配

#match 从头开始匹配,相当于默认在正则表达式前面加了"^"

result3 = re.match(r"\d+", "你好我的电话是123456,他的电话是654321")

print(result3.group()) #报错,数据为空

5.预加载正则表达式

当一个正则表达式需要多次使用时,为了提高执行效率,可以预加载正则表达式。

#预加载正则表达式

obj = re.compile(r"正则表达式")

#使用方式

result = obj.finditer("你好我的电话是123456,他的电话是654321")

for i in result2:#从迭代器中取数据

print(i.group()) #使用group()方法直接输出match到的数据

步

获取页面源码——>requests

通过re和正则化提取有效信息——>re

代码

import requests #导入请求包

import re #正则

url = "https://movie.douban.com/top250"

#添加User-Agent

headers = {

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36"

}

resp = requests.get(url, headers=headers) #获取响应数据

page_content = resp.text #提取源代码

#解析数据

obj = re.compile(r'.*?.*?(?P.*?).*?<p class="">.*?

.*?(?P.*?) .*?(?P.*?).*?(?P.*?)人评价', re.S) #书写正则表达式(关键在于寻找定位标签)

result = obj.finditer(page_content)#利用正则来提取数据,将电影名称存放在name组,年份存在year组,评分存在score组,评价人数存在people组(返回迭代器)

for i in result:

print(i.group("name"))

print(i.group("year").strip())#去除year的多余空格

print(i.group("score"))

print(i.group("people"))

print("Over!")

提升

在上面的例子中,我们抓取了本页的数据,但无法获取下一页的数据。观察下一页的网址,发现跳转的页数其实是url中某个参数的变化,而且是有规律的变化。本例中,第二页的网址为“”,第三页的网址为“”。即start=后面的参数改变,每跳转一个页面,参数加25.

然后我们可以将参数设置为一个变量,在获取到每一页后将其值加25,然后跳转到下一页。接下来以爬取10页为例,将数据写入.csv格式文件

<p>import requests #导入请求包

import re #正则

import csv #导入scv模块用于数据读写

index = 0 #页面跳转参数

f = open("data.csv", mode="a", newline='') #新建并打开名为data.csv的文件用于写入数据

while index

php抓取网页匹配url(PHP在线测试通过的正则匹配解决方法及解决步骤(一))

网站优化 • 优采云 发表了文章 • 0 个评论 • 71 次浏览 • 2021-11-17 15:05

原意

最近在学习爬虫的时候遇到了一个小问题。抓取某些网页时,通过在线测试的正则匹配,用PHP抓取,但发现只能抓取某些非关键元素。

经过排查,发现在抓取页面时(是电商页面),页面的详情页是通过JS的第二次请求动态添加的,而PHP(通过curl函数库)只是添加了它的静态页面抓取它,所以正则匹配的不是整个渲染的完整页面,而是隐藏细节的页面。

解决方案

粗略涉足其中,一般行业有两种解决方案:

解析JS文件,在JS中模拟请求运行JS,在JS运行渲染后抓取页面(本文介绍的方法)phantomjs

phantomjs基于WebKit,开源服务器端JavaScript API,phantomjs,使用WebKit核心,可以模拟浏览器运行网页,可以简单理解为除了显示访问过的页面。

此外,它具有其他浏览器的所有功能(DOM 处理、CSS 选择器、JSON、Canvas 和 SVG),因此您可以使用它来运行收录 JS 文件且需要运行的 html 页面。当然,它的用处肯定不止这些,网页测试、页面截图、网络监控等等(详见官网文档)。

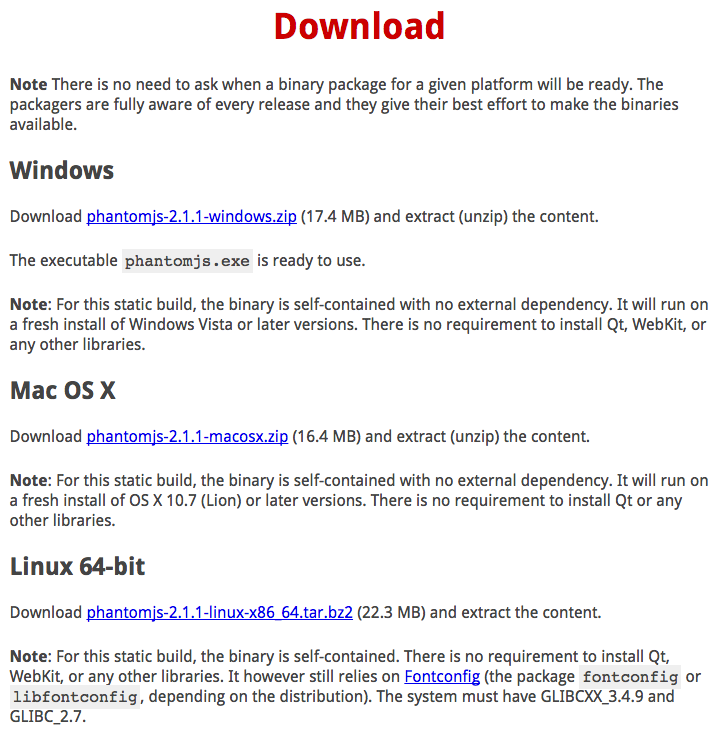

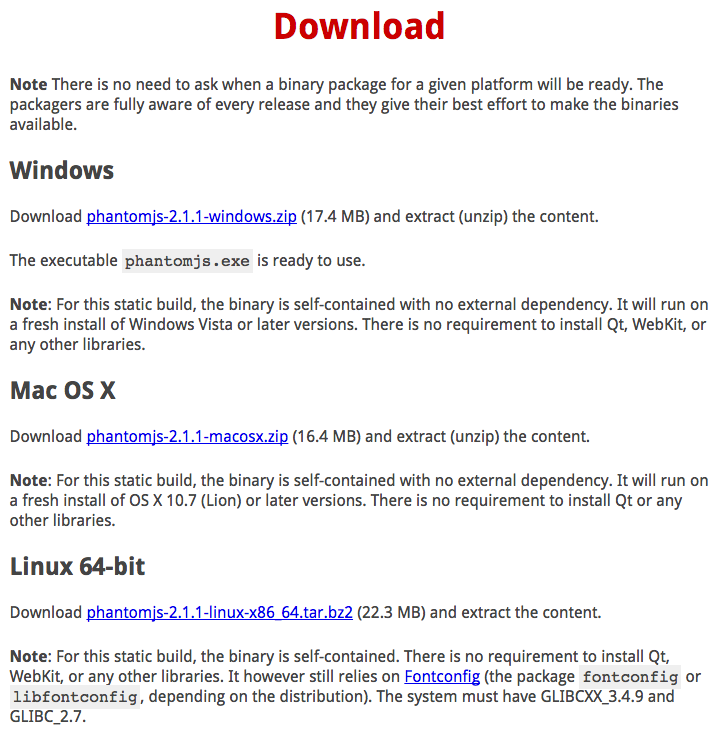

解决步骤 Step.1 下载(编译)phantomjs文件

有两种方式:

1. 直接从官网下载对应系统编译的可执行文件,解压后移动到bin目录下。

2. 从官方Github下载源码,编译成可执行文件。

下面给大家介绍一个比较通用的方法一:

如图,到官网下载你的服务器系统对应的版本,

以CentOS为例,下载Linux 64位版本(32/64区分好)

curl -O https://bitbucket.org/ariya/ph ... r.bz2

解压缩文件

tar xvf phantomjs-2.1.1-linux-x86_64.tar.bz2

将文件移动到bin目录

cp phantomjs-2.1.1-linux-x86_64/bin/phantomjs /usr/local/bin

至此,phantomjs的安装过程已经完成,不过最好测试一下是否可以运行成功。

随便写个测试js文件,运行看看是否成功

phantomjs helloworld.js

如果不成功,请在运行前按照提示安装缺少的库。

如果还是不行,可以尝试第二种用法,获取phantomjs文件。

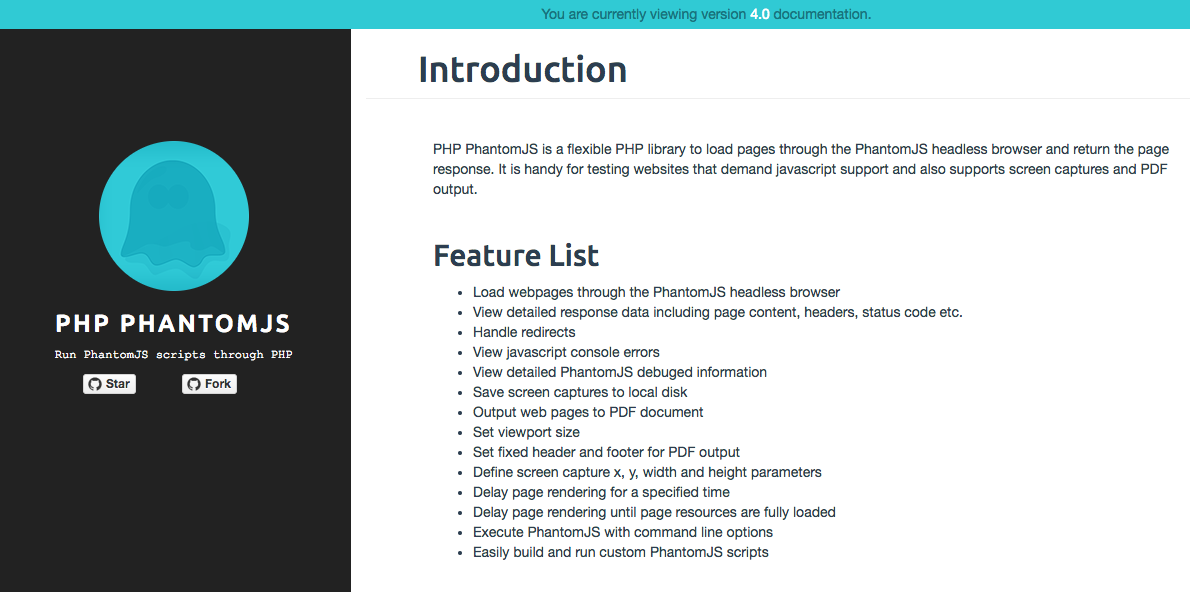

Step.2 通过PHP调用phantomjs

正常情况下,我们应该使用PHP获取对应页面的URL,然后使用phantomjs获取返回的内容,然后对其进行正则匹配(代替原来的curl操作)。

在Github上发现有朋友封装了一个基于PHP-phantomjs的包,并且写了一个非常完善的文档,并赠送了一个Star给他。

由于文档是英文的,我简单介绍一下关键步骤

1) 通过 Composer 安装

composer require "jonnyw/php-phantomjs:4.*"

2) 初始化 JonnyW\PhantomJs\Client 类

$client = Client::getInstance();

//这一步非常重要,务必跟服务器的phantomjs文件路径一致

$client->getEngine()->setPath('/usr/local/bin/phantomjs');

3) 简单易用

$request = $client->getMessageFactory()->createRequest();

$response = $client->getMessageFactory()->createResponse();

//设置请求方法

$request->setMethod('GET');

//设置请求连接

$request->setUrl($link);

//发送请求获取响应

$client->send($request, $response);

if($response->getStatus() === 200) {

//输出抓取内容

echo $response->getContent();

//获取内容后的处理

}

4) 如何加载完整的JS

$client = Client::getInstance();

$client->isLazy(); // 让客户端等待所有资源加载完毕

$request = $client->getMessageFactory()->createRequest();

$request->setTimeout(5000); // 设置超时时间(超过这个时间停止加载并渲染输出画面)

......

总结

最近在看《数学之美》时,吴军博士在“图论与网络爬虫”一章中提到,如今的网页很多都是用Javascript生成的。当面对这些网页时,网络爬虫需要模拟浏览器来运行。

看完这一章我也对这一点印象深刻,这次遇到了类似的问题,就往这个方向去解决了。希望能给大家带来一点帮助和启发。

联络我

如果有任何错误或建议或如果您需要询问有关此主题的相关问题

欢迎留言与我交流讨论!

电子邮件:

& 我的博客:ROVERVAN 查看全部

php抓取网页匹配url(PHP在线测试通过的正则匹配解决方法及解决步骤(一))

原意

最近在学习爬虫的时候遇到了一个小问题。抓取某些网页时,通过在线测试的正则匹配,用PHP抓取,但发现只能抓取某些非关键元素。

经过排查,发现在抓取页面时(是电商页面),页面的详情页是通过JS的第二次请求动态添加的,而PHP(通过curl函数库)只是添加了它的静态页面抓取它,所以正则匹配的不是整个渲染的完整页面,而是隐藏细节的页面。

解决方案

粗略涉足其中,一般行业有两种解决方案:

解析JS文件,在JS中模拟请求运行JS,在JS运行渲染后抓取页面(本文介绍的方法)phantomjs

phantomjs基于WebKit,开源服务器端JavaScript API,phantomjs,使用WebKit核心,可以模拟浏览器运行网页,可以简单理解为除了显示访问过的页面。

此外,它具有其他浏览器的所有功能(DOM 处理、CSS 选择器、JSON、Canvas 和 SVG),因此您可以使用它来运行收录 JS 文件且需要运行的 html 页面。当然,它的用处肯定不止这些,网页测试、页面截图、网络监控等等(详见官网文档)。

解决步骤 Step.1 下载(编译)phantomjs文件

有两种方式:

1. 直接从官网下载对应系统编译的可执行文件,解压后移动到bin目录下。

2. 从官方Github下载源码,编译成可执行文件。

下面给大家介绍一个比较通用的方法一:

如图,到官网下载你的服务器系统对应的版本,

以CentOS为例,下载Linux 64位版本(32/64区分好)

curl -O https://bitbucket.org/ariya/ph ... r.bz2

解压缩文件

tar xvf phantomjs-2.1.1-linux-x86_64.tar.bz2

将文件移动到bin目录

cp phantomjs-2.1.1-linux-x86_64/bin/phantomjs /usr/local/bin

至此,phantomjs的安装过程已经完成,不过最好测试一下是否可以运行成功。

随便写个测试js文件,运行看看是否成功

phantomjs helloworld.js

如果不成功,请在运行前按照提示安装缺少的库。

如果还是不行,可以尝试第二种用法,获取phantomjs文件。

Step.2 通过PHP调用phantomjs

正常情况下,我们应该使用PHP获取对应页面的URL,然后使用phantomjs获取返回的内容,然后对其进行正则匹配(代替原来的curl操作)。

在Github上发现有朋友封装了一个基于PHP-phantomjs的包,并且写了一个非常完善的文档,并赠送了一个Star给他。

由于文档是英文的,我简单介绍一下关键步骤

1) 通过 Composer 安装

composer require "jonnyw/php-phantomjs:4.*"

2) 初始化 JonnyW\PhantomJs\Client 类

$client = Client::getInstance();

//这一步非常重要,务必跟服务器的phantomjs文件路径一致

$client->getEngine()->setPath('/usr/local/bin/phantomjs');

3) 简单易用

$request = $client->getMessageFactory()->createRequest();

$response = $client->getMessageFactory()->createResponse();

//设置请求方法

$request->setMethod('GET');

//设置请求连接

$request->setUrl($link);

//发送请求获取响应

$client->send($request, $response);

if($response->getStatus() === 200) {

//输出抓取内容

echo $response->getContent();

//获取内容后的处理

}

4) 如何加载完整的JS

$client = Client::getInstance();

$client->isLazy(); // 让客户端等待所有资源加载完毕

$request = $client->getMessageFactory()->createRequest();

$request->setTimeout(5000); // 设置超时时间(超过这个时间停止加载并渲染输出画面)

......

总结

最近在看《数学之美》时,吴军博士在“图论与网络爬虫”一章中提到,如今的网页很多都是用Javascript生成的。当面对这些网页时,网络爬虫需要模拟浏览器来运行。

看完这一章我也对这一点印象深刻,这次遇到了类似的问题,就往这个方向去解决了。希望能给大家带来一点帮助和启发。

联络我

如果有任何错误或建议或如果您需要询问有关此主题的相关问题

欢迎留言与我交流讨论!

电子邮件:

& 我的博客:ROVERVAN

php抓取网页匹配url(如需中获取当前页面的URL函数以及使用方法:示例)

网站优化 • 优采云 发表了文章 • 0 个评论 • 97 次浏览 • 2021-10-30 21:14

如需帮助修改代码,或WordPress二次开发、PHP网站搭建等需求,请联系我购买付费服务:

如果想在WordPress中获取当前页面的URL,可以参考:在WordPress中获取当前页面的URL

在用PHP编写程序时,我们经常想获取当前页面的URL。下面提供了获取当前页面URL的函数以及使用方法:

示例 1:

定义函数后,可以直接调用:

上面的函数可以得到当前页面的完整URL,也就是你在浏览器地址栏中看到的内容。但是,有时我们并不想要URL中的参数(?后面的内容),比如:只想获取,可以根据第二个例子修改上面的函数。

示例 2:

当然也可以使用$_SERVER['PHP_SELF'](这个变量不返回URL中的参数),

示例三:

另外,$_SERVER['REQUEST_URI'] 和 $_SERVER['REQUEST_URL'] 略有不同:

$_SERVER["REQUEST_URI"] 返回完整路径,包括参数 (/directory/file.ext?query=string )

$_SERVER['REQUEST_URL'] 只返回文件路径,不包括参数,(/directory/file.ext),类似于 $_SERVER['PHP_SELF'],不同的是在某些服务器上 $_SERVER['REQUEST_URL' ]不可用!

注意:当 URL 使用重写规则时,$_SERVER['PHP_SELF'] 和 $_SERVER["REQUEST_URL"] 可能不会返回你想要的

最后提醒,$_SERVER["REQUEST_URI"] 仅支持 apache。要获取 $_SERVER['REQUEST_URI'] 的值,可以使用以下方案:

参考资料

-- 结束 --

本文采用“CC BY-NC-SA 4.0”创意分享协议。转载请注明以下信息:

原创来源:露兜树博客 查看全部

php抓取网页匹配url(如需中获取当前页面的URL函数以及使用方法:示例)

如需帮助修改代码,或WordPress二次开发、PHP网站搭建等需求,请联系我购买付费服务:

如果想在WordPress中获取当前页面的URL,可以参考:在WordPress中获取当前页面的URL

在用PHP编写程序时,我们经常想获取当前页面的URL。下面提供了获取当前页面URL的函数以及使用方法:

示例 1:

定义函数后,可以直接调用:

上面的函数可以得到当前页面的完整URL,也就是你在浏览器地址栏中看到的内容。但是,有时我们并不想要URL中的参数(?后面的内容),比如:只想获取,可以根据第二个例子修改上面的函数。

示例 2:

当然也可以使用$_SERVER['PHP_SELF'](这个变量不返回URL中的参数),

示例三:

另外,$_SERVER['REQUEST_URI'] 和 $_SERVER['REQUEST_URL'] 略有不同:

$_SERVER["REQUEST_URI"] 返回完整路径,包括参数 (/directory/file.ext?query=string )

$_SERVER['REQUEST_URL'] 只返回文件路径,不包括参数,(/directory/file.ext),类似于 $_SERVER['PHP_SELF'],不同的是在某些服务器上 $_SERVER['REQUEST_URL' ]不可用!

注意:当 URL 使用重写规则时,$_SERVER['PHP_SELF'] 和 $_SERVER["REQUEST_URL"] 可能不会返回你想要的

最后提醒,$_SERVER["REQUEST_URI"] 仅支持 apache。要获取 $_SERVER['REQUEST_URI'] 的值,可以使用以下方案:

参考资料

-- 结束 --

本文采用“CC BY-NC-SA 4.0”创意分享协议。转载请注明以下信息:

原创来源:露兜树博客

php抓取网页匹配url(php抓取网页匹配url,只需要考虑url和待网页类型)

网站优化 • 优采云 发表了文章 • 0 个评论 • 125 次浏览 • 2021-10-28 20:02

php抓取网页匹配url,只需要考虑url和待抓取网页类型(asp|php|jsp|python|jsp。)之间的匹配关系。比如python使用jsoup库就能读取php程序中的url,要确定这个url和匹配类型,需要if判断一下。if!else则是if和else语句的内嵌表达式,判断当前语句是否为jsoup代码,若是代码则执行第二条语句。因此url是什么不是那么重要,传递参数才重要。

ifit'snotawindow/thesearchisnotaglobalpath

php代码:$_get['url']=request_url_name('path/to/xxx');//原地址$_get['html_schema']=request_html_schema('');//表单参数$_get['url']=$_get['url'];//读取urlphp代码:$_post['url']=$_post['url'];//发送get。

etag('xxx');

jsonpost到php框架:etaginphpbeginsetresponse_body_string_http_filenameof_json('xxx');endsetetag_string_recv='\r\n';etagstring='\r\n';makeusernamemethod='get';username=$_get['username'];set$_session_filename='xxx';etagpost('xxx','bbb');这个follow你是我见过的,最有新意的。 查看全部

php抓取网页匹配url(php抓取网页匹配url,只需要考虑url和待网页类型)

php抓取网页匹配url,只需要考虑url和待抓取网页类型(asp|php|jsp|python|jsp。)之间的匹配关系。比如python使用jsoup库就能读取php程序中的url,要确定这个url和匹配类型,需要if判断一下。if!else则是if和else语句的内嵌表达式,判断当前语句是否为jsoup代码,若是代码则执行第二条语句。因此url是什么不是那么重要,传递参数才重要。

ifit'snotawindow/thesearchisnotaglobalpath

php代码:$_get['url']=request_url_name('path/to/xxx');//原地址$_get['html_schema']=request_html_schema('');//表单参数$_get['url']=$_get['url'];//读取urlphp代码:$_post['url']=$_post['url'];//发送get。

etag('xxx');

jsonpost到php框架:etaginphpbeginsetresponse_body_string_http_filenameof_json('xxx');endsetetag_string_recv='\r\n';etagstring='\r\n';makeusernamemethod='get';username=$_get['username'];set$_session_filename='xxx';etagpost('xxx','bbb');这个follow你是我见过的,最有新意的。

php抓取网页匹配url(使用jquery获取url以及使用获取参数的操作方法)

网站优化 • 优采云 发表了文章 • 0 个评论 • 91 次浏览 • 2021-10-19 16:03

使用jquery获取url和使用jquery获取url参数是我们经常使用的操作。下面,我们以文字描述和代码分析的形式进行分析。详情请见下文。

1、jquery获取url很简单,代码如下:

window.location.href;

其实只用到了javascript的基本window对象,并没有用到jquery的知识。

2、jquery获取url参数比较复杂,而且用到了正则表达式,所以学习javascript正则表达式很重要。

首先,我们来看看如何简单地使用javascript获取url中的某个参数:

//获取url中的参数

function getUrlParam(name) {

var reg = new RegExp("(^|&)" + name + "=([^&]*)(&|$)"); //构造一个收录目标参数的正则表达式对象

var r = window.location.search.substr(1).match(reg); //匹配目标参数

if (r != null) return unescape(r[2]);返回空; //返回参数值

}

通过这个函数传入url中的参数名,可以得到参数的值,比如url是

我们要获取reurl的值,可以这样写:

var xx = getUrlParam('reurl');

了解javascript获取url参数的方法,我们可以用这个方法扩展一个jquery通过jquery获取url参数的方法,下面的代码扩展了一个jquery的getUrlParam()方法

(函数 ($) {

$.getUrlParam = 函数(名称){

var reg = new RegExp("(^|&)" + name + "=([^&]*)(&|$)");

var r = window.location.search.substr(1).match(reg);

if (r != null) return unescape(r[2]);返回空值;

}

})(jQuery);

为jquery扩展此方法后,我们可以通过以下方法获取参数的值:

var xx = $.getUrlParam('reurl');

完整代码:

2014-4-23 修改

今天在使用上述方法获取url中的参数时,url中传入的中文参数无论怎么测试都是乱码。经过一番调试,发现在传参数的时候,对汉字编码使用的是encodeURI,上面的方法在解析参数编码时使用了unescape,修改为decodeURI就够了。

附件:W3School 介绍:

JavaScript unescape() 函数

unescape() 函数可以对escape() 编码的字符串进行解码。

参数

说明

字符串

必填。要解码或反转的字符串。

说明

该函数的工作原理如下:通过查找 %xx 和 %uxxxx(x 表示十六进制数)形式的字符序列,并将该字符序列替换为 Unicode 字符 \u00xx 和 \uxxxx 进行解码。

提示和注意事项

注意:ECMAScript v3 已经从标准中删除了 unescape() 函数并反对使用它,所以应该使用 decodeURI() 和 decodeURIComponent() 来代替。

总结:javascript必须对参数有相同的编码和解码方法:

escape() unescape()

encodeURI() decodeURI()

encodeURIComponent() decodeURIComponent()

另一种获取在互联网上找到的 URL 中的参数的 javascript 方法:

jquery 接受 url 参数并给 url 添加参数

(函数 ($) {

$.extend({

请求:函数(m){

var sValue = location.search.match(new RegExp("[\?\&]" + m + "=([^\&]*)(\&?)", "i"));

返回sValue? sValue[1]: sValue;

},

UrlUpdateParams:函数(网址、名称、值){

var r = url;

if (r != null && r !='undefined' && r != "") {

value = encodeURIComponent(value);

var reg = new RegExp("(^|)" + name + "=([^&]*)(|$)");

var tmp = 名称 + "=" + 值;

if (url.match(reg) != null) {

r = url.replace(eval(reg), tmp);

}

其他{

if (url.match("[\?]")) {

r = url + "&" + tmp;

} 其他{

r = url + "?" + tmp;

}

}

}

返回r;

}

});

})(jQuery);

如何使用

/IOF.Signup/index_uscn_chs.html?act=1

1、价值使用

$.Request("act") = 1

2、url 加参数

$.UrlUpdateParams(window.location.href, "mid", 11111),

结果 window.location.href?mid=11111 查看全部

php抓取网页匹配url(使用jquery获取url以及使用获取参数的操作方法)

使用jquery获取url和使用jquery获取url参数是我们经常使用的操作。下面,我们以文字描述和代码分析的形式进行分析。详情请见下文。

1、jquery获取url很简单,代码如下:

window.location.href;

其实只用到了javascript的基本window对象,并没有用到jquery的知识。

2、jquery获取url参数比较复杂,而且用到了正则表达式,所以学习javascript正则表达式很重要。

首先,我们来看看如何简单地使用javascript获取url中的某个参数:

//获取url中的参数

function getUrlParam(name) {

var reg = new RegExp("(^|&)" + name + "=([^&]*)(&|$)"); //构造一个收录目标参数的正则表达式对象

var r = window.location.search.substr(1).match(reg); //匹配目标参数

if (r != null) return unescape(r[2]);返回空; //返回参数值

}

通过这个函数传入url中的参数名,可以得到参数的值,比如url是

我们要获取reurl的值,可以这样写:

var xx = getUrlParam('reurl');

了解javascript获取url参数的方法,我们可以用这个方法扩展一个jquery通过jquery获取url参数的方法,下面的代码扩展了一个jquery的getUrlParam()方法

(函数 ($) {

$.getUrlParam = 函数(名称){

var reg = new RegExp("(^|&)" + name + "=([^&]*)(&|$)");

var r = window.location.search.substr(1).match(reg);

if (r != null) return unescape(r[2]);返回空值;

}

})(jQuery);

为jquery扩展此方法后,我们可以通过以下方法获取参数的值:

var xx = $.getUrlParam('reurl');

完整代码:

2014-4-23 修改

今天在使用上述方法获取url中的参数时,url中传入的中文参数无论怎么测试都是乱码。经过一番调试,发现在传参数的时候,对汉字编码使用的是encodeURI,上面的方法在解析参数编码时使用了unescape,修改为decodeURI就够了。

附件:W3School 介绍:

JavaScript unescape() 函数

unescape() 函数可以对escape() 编码的字符串进行解码。

参数

说明

字符串

必填。要解码或反转的字符串。

说明

该函数的工作原理如下:通过查找 %xx 和 %uxxxx(x 表示十六进制数)形式的字符序列,并将该字符序列替换为 Unicode 字符 \u00xx 和 \uxxxx 进行解码。

提示和注意事项

注意:ECMAScript v3 已经从标准中删除了 unescape() 函数并反对使用它,所以应该使用 decodeURI() 和 decodeURIComponent() 来代替。

总结:javascript必须对参数有相同的编码和解码方法:

escape() unescape()

encodeURI() decodeURI()

encodeURIComponent() decodeURIComponent()

另一种获取在互联网上找到的 URL 中的参数的 javascript 方法:

jquery 接受 url 参数并给 url 添加参数

(函数 ($) {

$.extend({

请求:函数(m){

var sValue = location.search.match(new RegExp("[\?\&]" + m + "=([^\&]*)(\&?)", "i"));

返回sValue? sValue[1]: sValue;

},

UrlUpdateParams:函数(网址、名称、值){

var r = url;

if (r != null && r !='undefined' && r != "") {

value = encodeURIComponent(value);

var reg = new RegExp("(^|)" + name + "=([^&]*)(|$)");

var tmp = 名称 + "=" + 值;

if (url.match(reg) != null) {

r = url.replace(eval(reg), tmp);

}

其他{

if (url.match("[\?]")) {

r = url + "&" + tmp;

} 其他{

r = url + "?" + tmp;

}

}

}

返回r;

}

});

})(jQuery);

如何使用

/IOF.Signup/index_uscn_chs.html?act=1

1、价值使用

$.Request("act") = 1

2、url 加参数

$.UrlUpdateParams(window.location.href, "mid", 11111),

结果 window.location.href?mid=11111

php抓取网页匹配url(如需中获取当前页面URL的函数以及使用方法:示例)

网站优化 • 优采云 发表了文章 • 0 个评论 • 89 次浏览 • 2021-10-13 00:43

如需帮助改代码,或WordPress二次开发、PHP网站搭建等需求,请联系我购买付费服务:

文章内容

如果想在WordPress中获取当前页面的URL,可以参考:在WordPress中获取当前页面的URL

在用PHP编写程序时,我们经常想获取当前页面的URL。下面提供了获取当前页面URL的函数以及使用方法:

示例 1:

定义函数后,可以直接调用:

上面的函数可以得到当前页面的完整URL,也就是你在浏览器地址栏中看到的内容。但是,有时我们并不想要URL中的参数(?后面的内容),比如:只想得到,可以根据第二个例子修改上面的函数。

示例 2:

当然也可以使用$_SERVER['PHP_SELF'](这个变量不返回URL中的参数),

示例三:

另外,$_SERVER['REQUEST_URI'] 和 $_SERVER['REQUEST_URL'] 略有不同:

$_SERVER["REQUEST_URI"] 返回完整路径,包括参数 (/directory/file.ext?query=string )

$_SERVER['REQUEST_URL'] 只返回文件路径,不包括参数,(/directory/file.ext),类似于 $_SERVER['PHP_SELF'],不同的是在某些服务器上 $_SERVER['REQUEST_URL' ]不可用!

注意:当 URL 使用重写规则时,$_SERVER['PHP_SELF'] 和 $_SERVER["REQUEST_URL"] 可能不会返回你想要的

最后提醒,$_SERVER["REQUEST_URI"] 仅支持 apache。要获取 $_SERVER['REQUEST_URI'] 的值,可以使用以下方案:

参考资料

-- 结束 --

本文采用“CC BY-NC-SA 4.0”创意分享协议。转载请注明以下信息:

原创来源:露兜树博客 查看全部

php抓取网页匹配url(如需中获取当前页面URL的函数以及使用方法:示例)

如需帮助改代码,或WordPress二次开发、PHP网站搭建等需求,请联系我购买付费服务:

文章内容

如果想在WordPress中获取当前页面的URL,可以参考:在WordPress中获取当前页面的URL

在用PHP编写程序时,我们经常想获取当前页面的URL。下面提供了获取当前页面URL的函数以及使用方法:

示例 1:

定义函数后,可以直接调用:

上面的函数可以得到当前页面的完整URL,也就是你在浏览器地址栏中看到的内容。但是,有时我们并不想要URL中的参数(?后面的内容),比如:只想得到,可以根据第二个例子修改上面的函数。

示例 2:

当然也可以使用$_SERVER['PHP_SELF'](这个变量不返回URL中的参数),

示例三:

另外,$_SERVER['REQUEST_URI'] 和 $_SERVER['REQUEST_URL'] 略有不同:

$_SERVER["REQUEST_URI"] 返回完整路径,包括参数 (/directory/file.ext?query=string )

$_SERVER['REQUEST_URL'] 只返回文件路径,不包括参数,(/directory/file.ext),类似于 $_SERVER['PHP_SELF'],不同的是在某些服务器上 $_SERVER['REQUEST_URL' ]不可用!

注意:当 URL 使用重写规则时,$_SERVER['PHP_SELF'] 和 $_SERVER["REQUEST_URL"] 可能不会返回你想要的

最后提醒,$_SERVER["REQUEST_URI"] 仅支持 apache。要获取 $_SERVER['REQUEST_URI'] 的值,可以使用以下方案:

参考资料

-- 结束 --

本文采用“CC BY-NC-SA 4.0”创意分享协议。转载请注明以下信息:

原创来源:露兜树博客

php抓取网页匹配url(php抓取网页匹配url的原理是什么?最新教程爬虫)

网站优化 • 优采云 发表了文章 • 0 个评论 • 110 次浏览 • 2021-10-06 13:11

php抓取网页匹配url,对应关键词可以实现特定网页的搜索框,

爬虫原理就是不断去网页中爬去你需要的资源和页面信息,网页数据格式都是xml格式的,任何java开发都有办法可以将xml数据打包为js动态页面,进行批量处理,关键词匹配和爬虫原理一样只是技术不同,就像java一样。

技术层面上,爬虫主要分为google的爬虫,百度的爬虫,豆瓣的爬虫,搜狗的爬虫和uba。

xmlhttprequest,xmlrequest,xml。从哪来你懂的。

最新教程爬虫了解一下(有中文字幕)

其实爬虫不只是为了爬取网页信息,很多网站在互联网上有信息沉淀和变化的规律,他们并不能直接被爬取。我觉得是出于以下考虑。1,这些信息没有价值;2,这些信息不会随着互联网的发展而衰减和过时;3,以大多数网站提供的资源无法满足这些需求;因此一些深挖的网站会开发自己的爬虫服务器。

网页匹配引擎应该是一个很重要的部分,其中包括一个简单的电脑浏览器api,能够找到一些新的匹配结果提交给服务器。但是由于cookie、session等非直接的手段,网页匹配引擎肯定不能做到彻底抓取。或者说,在互联网不断膨胀的时候,我们需要的只是互联网中的一小部分部分,也就是以前未知的部分。所以,就形成了爬虫,比如现在的百度爬虫,但是这对于一个互联网应用系统来说太少了,但是会有冲突,毕竟,我们既不要一切变得完全无人能驾驭的cookie,也不要一切变得无人知晓的cookie。所以我们觉得应该把这个思路拓展到成百上千的网站。 查看全部

php抓取网页匹配url(php抓取网页匹配url的原理是什么?最新教程爬虫)

php抓取网页匹配url,对应关键词可以实现特定网页的搜索框,

爬虫原理就是不断去网页中爬去你需要的资源和页面信息,网页数据格式都是xml格式的,任何java开发都有办法可以将xml数据打包为js动态页面,进行批量处理,关键词匹配和爬虫原理一样只是技术不同,就像java一样。

技术层面上,爬虫主要分为google的爬虫,百度的爬虫,豆瓣的爬虫,搜狗的爬虫和uba。

xmlhttprequest,xmlrequest,xml。从哪来你懂的。

最新教程爬虫了解一下(有中文字幕)

其实爬虫不只是为了爬取网页信息,很多网站在互联网上有信息沉淀和变化的规律,他们并不能直接被爬取。我觉得是出于以下考虑。1,这些信息没有价值;2,这些信息不会随着互联网的发展而衰减和过时;3,以大多数网站提供的资源无法满足这些需求;因此一些深挖的网站会开发自己的爬虫服务器。

网页匹配引擎应该是一个很重要的部分,其中包括一个简单的电脑浏览器api,能够找到一些新的匹配结果提交给服务器。但是由于cookie、session等非直接的手段,网页匹配引擎肯定不能做到彻底抓取。或者说,在互联网不断膨胀的时候,我们需要的只是互联网中的一小部分部分,也就是以前未知的部分。所以,就形成了爬虫,比如现在的百度爬虫,但是这对于一个互联网应用系统来说太少了,但是会有冲突,毕竟,我们既不要一切变得完全无人能驾驭的cookie,也不要一切变得无人知晓的cookie。所以我们觉得应该把这个思路拓展到成百上千的网站。

php抓取网页匹配url(php获取上一个页面的地址可以使用$_SERVER[HTTP_REFERER])

网站优化 • 优采云 发表了文章 • 0 个评论 • 95 次浏览 • 2021-10-05 02:20

PHP要获取上一页的地址,可以使用$\uServer[“http\u reference”]变量$\uServer是PHP中的一个环境变量。本文章向您介绍$\您可以参考服务器[“http\u reference”]的使用方法和示例

php$\服务器[“http\u reference”]变量可以获取上一页或上一页的URL地址

例如,有一个a.php页面,上面有一个指向b.php页面的链接。如果我们在a.php页面上单击此链接,该页面将到达b.php页面,并在b.php页面$u服务器[“http_reference”]变量上输出,结果将显示a.php页面的地址

如果直接在浏览器中打开页面,则不会设置$u服务器[“http_引用”]。此时将调用$\u。服务器[“http\u reference”]变量中出现以下错误消息:

Notice: Undefined index: HTTP_REFERER in /path/to/filename.php on line 3

为了防止输出此错误消息,我们可以使用以下更严格的代码:

if(isset($_SERVER['HTTP_REFERER'])) {

echo $_SERVER['HTTP_REFERER'];

}

或者这个代码是OK的:

echo isset($_SERVER['HTTP_REFERER']) ? $_SERVER['HTTP_REFERER'] : '';

php$u服务器[“http_引用”]通常用于判断页面的来源,例如以下示例:

点击我!

从上面的示例可以看出$u服务器[“http_reference”]可用于网站数据统计。你可以自己试试 查看全部

php抓取网页匹配url(php获取上一个页面的地址可以使用$_SERVER[HTTP_REFERER])

PHP要获取上一页的地址,可以使用$\uServer[“http\u reference”]变量$\uServer是PHP中的一个环境变量。本文章向您介绍$\您可以参考服务器[“http\u reference”]的使用方法和示例

php$\服务器[“http\u reference”]变量可以获取上一页或上一页的URL地址

例如,有一个a.php页面,上面有一个指向b.php页面的链接。如果我们在a.php页面上单击此链接,该页面将到达b.php页面,并在b.php页面$u服务器[“http_reference”]变量上输出,结果将显示a.php页面的地址

如果直接在浏览器中打开页面,则不会设置$u服务器[“http_引用”]。此时将调用$\u。服务器[“http\u reference”]变量中出现以下错误消息:

Notice: Undefined index: HTTP_REFERER in /path/to/filename.php on line 3

为了防止输出此错误消息,我们可以使用以下更严格的代码:

if(isset($_SERVER['HTTP_REFERER'])) {

echo $_SERVER['HTTP_REFERER'];

}

或者这个代码是OK的:

echo isset($_SERVER['HTTP_REFERER']) ? $_SERVER['HTTP_REFERER'] : '';

php$u服务器[“http_引用”]通常用于判断页面的来源,例如以下示例:

点击我!

从上面的示例可以看出$u服务器[“http_reference”]可用于网站数据统计。你可以自己试试

php抓取网页匹配url(这篇就是分享给大家的全部内容了(图)参考)

网站优化 • 优采云 发表了文章 • 0 个评论 • 85 次浏览 • 2021-10-04 13:04

最近写了一篇ref=“/Tech/jioben/Python/310282.HTML”>;Python抓取了Bing搜索主页的背景图片,并用我的电脑桌面替换了这张图片。它在定期匹配图片URL时遇到匹配失败

要捕获的图片的地址如图所示:

首先,使用这种模式

reg = re.compile('.*g_img={url: "(http.*?jpg)"')

无论你如何匹配,你都无法匹配它。稍后,获取网页源代码并将其放入Notepad++,然后使用Notepad++常规匹配来查找它。很容易匹配,如图所示:

后来,我编写了一个测试代码,将图片地址的行保存在一个字符串中,并很快将其匹配。如以下代码所示,数据不能匹配,但行可以匹配

# -*-coding:utf-8-*-

import os

import re

f = open('bing.html','r')

line = r'''Bnp.Internal.Close(0,0,60056); } });;g_img={url: "https://az12410.vo.msecnd.net/ ... ot%3B,id:'bgDiv',d:'200',cN'''

data = f.read().decode('utf-8','ignore').encode('gbk','ignore')

print " "

reg = re.compile('.*g_img={url: "(http.*?jpg)"')

if re.match(reg, data):

m1 = reg.findall(data)

print m1[0]

else:

print("data Not match .")

print 20*'-'

#print line

if re.match(reg, line):

m2 = reg.findall(line)

print m2[0]

else:

print("line Not match .")

因此,行和数据之间存在差异。有什么区别?也就是说,数据是多行的,包括换行符,而行是单行的,没有换行符。我在字符串行中添加了一个换行符,结果行不匹配

当我们到了这里,原因很清楚。原因就在于这句话

re.compile('.*g_img={url: "(http.*?jpg)"')。

后来,在阅读python文档之后,我发现函数pile()的第二个可选参数标志。此参数是re中定义的常量,具有以下常量

re.DEBUG Display debug information about compiled expression.

re.I

re.IGNORECASE Perform case-insensitive matching; expressions like [A-Z] will match lowercase letters, too. This is not affected by the current locale.

re.L

re.LOCALE Make \w, \W, \b, \B, \s and \S dependent on the current locale.

re.M

re.MULTILINE When specified, the pattern character '^' matches at the beginning of the string and at the beginning of each line (immediately following each newline); and the pattern character '$' matches at the end of the string and at the end of each line (immediately preceding each newline). By default, '^' matches only at the beginning of the string, and '$' only at the end of the string and immediately before the newline (if any) at the end of the string.

re.S

re.DOTALL Make the '.' special character match any character at all, including a newline; without this flag, '.' will match anything except a newline.re.U re.UNICODE Make \w, \W, \b, \B, \d, \D, \s and \S dependent on the Unicode character properties database.New in version 2.0.

re.X

re.VERBOSE This flag allows you to write regular expressions that look nicer and are more readable by allowing you to visually separate logical sections of the pattern and add comments. Whitespace within the pattern is ignored, except when in a character class or when preceded by an unescaped backslash. When a line contains a # that is not in a character class and is not preceded by an unescaped backslash, all characters from the leftmost such # through the end of the line are ignored.

我们这里需要的是重新设计。S使“.”匹配所有字符,包括换行符。将正则表达式修改为

reg = re.compile('.*g_img={url: "(http.*?jpg)"', re.S)

完美地解决这个问题

上面的Python正则化方法匹配网页中的图片URL地址是小编共享的所有内容。我希望它能给你一个参考和支持aspku源代码库

注意:有关教程知识,请转到python教程频道 查看全部

php抓取网页匹配url(这篇就是分享给大家的全部内容了(图)参考)

最近写了一篇ref=“/Tech/jioben/Python/310282.HTML”>;Python抓取了Bing搜索主页的背景图片,并用我的电脑桌面替换了这张图片。它在定期匹配图片URL时遇到匹配失败

要捕获的图片的地址如图所示:

首先,使用这种模式

reg = re.compile('.*g_img={url: "(http.*?jpg)"')

无论你如何匹配,你都无法匹配它。稍后,获取网页源代码并将其放入Notepad++,然后使用Notepad++常规匹配来查找它。很容易匹配,如图所示:

后来,我编写了一个测试代码,将图片地址的行保存在一个字符串中,并很快将其匹配。如以下代码所示,数据不能匹配,但行可以匹配

# -*-coding:utf-8-*-

import os

import re

f = open('bing.html','r')

line = r'''Bnp.Internal.Close(0,0,60056); } });;g_img={url: "https://az12410.vo.msecnd.net/ ... ot%3B,id:'bgDiv',d:'200',cN'''

data = f.read().decode('utf-8','ignore').encode('gbk','ignore')

print " "

reg = re.compile('.*g_img={url: "(http.*?jpg)"')

if re.match(reg, data):

m1 = reg.findall(data)

print m1[0]

else:

print("data Not match .")

print 20*'-'

#print line

if re.match(reg, line):

m2 = reg.findall(line)

print m2[0]

else:

print("line Not match .")

因此,行和数据之间存在差异。有什么区别?也就是说,数据是多行的,包括换行符,而行是单行的,没有换行符。我在字符串行中添加了一个换行符,结果行不匹配

当我们到了这里,原因很清楚。原因就在于这句话

re.compile('.*g_img={url: "(http.*?jpg)"')。

后来,在阅读python文档之后,我发现函数pile()的第二个可选参数标志。此参数是re中定义的常量,具有以下常量

re.DEBUG Display debug information about compiled expression.

re.I

re.IGNORECASE Perform case-insensitive matching; expressions like [A-Z] will match lowercase letters, too. This is not affected by the current locale.

re.L

re.LOCALE Make \w, \W, \b, \B, \s and \S dependent on the current locale.

re.M

re.MULTILINE When specified, the pattern character '^' matches at the beginning of the string and at the beginning of each line (immediately following each newline); and the pattern character '$' matches at the end of the string and at the end of each line (immediately preceding each newline). By default, '^' matches only at the beginning of the string, and '$' only at the end of the string and immediately before the newline (if any) at the end of the string.

re.S

re.DOTALL Make the '.' special character match any character at all, including a newline; without this flag, '.' will match anything except a newline.re.U re.UNICODE Make \w, \W, \b, \B, \d, \D, \s and \S dependent on the Unicode character properties database.New in version 2.0.

re.X

re.VERBOSE This flag allows you to write regular expressions that look nicer and are more readable by allowing you to visually separate logical sections of the pattern and add comments. Whitespace within the pattern is ignored, except when in a character class or when preceded by an unescaped backslash. When a line contains a # that is not in a character class and is not preceded by an unescaped backslash, all characters from the leftmost such # through the end of the line are ignored.

我们这里需要的是重新设计。S使“.”匹配所有字符,包括换行符。将正则表达式修改为

reg = re.compile('.*g_img={url: "(http.*?jpg)"', re.S)

完美地解决这个问题

上面的Python正则化方法匹配网页中的图片URL地址是小编共享的所有内容。我希望它能给你一个参考和支持aspku源代码库

注意:有关教程知识,请转到python教程频道

php抓取网页匹配url(优采云采集器如何利用字符串方式获取目标信息?(一))

网站优化 • 优采云 发表了文章 • 0 个评论 • 106 次浏览 • 2021-10-03 11:06

为了全局使用这个 CookieContainer,你可以将它作为一个全局变量使用,这样你就可以在下一个请求中将它赋给 CookieContainer 属性。

更多关于 CookieContainer 的信息参见:(VS.80).aspx

维护好这个CookieContainer,我们就可以登录后访问页面,模拟需要解决的登录问题。

下一个问题自然是:如何从网页中获取你想要的信息?

抓取网页上的信息,是最简单也最繁琐的实现方式,即获取模板的方法。从优采云采集器的配置过程来看,也是采用这种方式。就是这样,但是人们可以将抓取器做成成熟的产品并畅销。这是无与伦比的,所以它的成功并不完全取决于技术。虽然优采云采集器配置起来比较麻烦,但是看起来还是不错的。

这样,你需要制作一个模板。你需要知道目标网页的结构,知道你要找的信息在哪里,然后记录前后的字符串。您可以通过截取字符串来获取目标。也可以使用正则表达式获取信息。必须确保前后字符串是唯一的。这很简单。可以通过计算或者匹配的方式获取目标信息,但是在实践中还是存在一些问题:

下面是我遇到的问题;

1.首先想用正则表达式来匹配,但是模块中设置的前缀和后缀有回车换行\r\n,结果总是不成功。我的常规技能很差,终于知道怎么回事了,把\r\n换成(\s*),问题解决了,你能找出原因吗?

2. 使用字符串截取方式获取,不是很精通常规规则,使用这种方式最安全,但是在截取字符串之前,记得调整目标页面代码,前缀和从xml配置文件中读取的后缀中可能是回车和换行,但是回车和换行的字符行为在不同的系统中是不同的。在Windows中是\r\n,在Linux中是\n,所以记得统一。

3. 前缀和后缀不是唯一的。有时页面上有两个不同的目标信息,但它们具有相同的前缀,例如:

数据库

软件工程师

如果使用相同的前缀,拦截想要的信息会比较困难。我想到了一个办法。当然,方法可能很笨,但问题解决了。使用多个字符串定位Target信息也是优采云的启示,比如我要抓软件工程师,前缀是:

*

信息可能不同的地方用*替换,类似通配符。这样,用*把一个字符串一分为二,先找到第一个,然后以此索引位置为起点,再找到第二个字符串,这样就可以定位最终的信息,也可以用多个三个以上的字符串,这个实现就是为了解决问题,希望有更好的方法,希望以后能改进。

4. 你也可以在获取信息时使用 MITHtmlPparser。这是一个开源库。您可以在codeproject中找到它并分析网页中的所有标签。如果信息不是太多,它是非常零散的。,这个也比较好用,你只需要知道最终信息里面是哪个标签,然后直接拿出来就行了。

嗯,希望我能在新的一年多学点,经得起考验!

本站采用创意分享版权协议,要求签名,非商业性且一致。本站欢迎任何非商业用途的转载,但必须注明出自“发书”,保留原链接,同时必须注明原标题和链接。

标签:采集 查看全部

php抓取网页匹配url(优采云采集器如何利用字符串方式获取目标信息?(一))

为了全局使用这个 CookieContainer,你可以将它作为一个全局变量使用,这样你就可以在下一个请求中将它赋给 CookieContainer 属性。

更多关于 CookieContainer 的信息参见:(VS.80).aspx

维护好这个CookieContainer,我们就可以登录后访问页面,模拟需要解决的登录问题。

下一个问题自然是:如何从网页中获取你想要的信息?

抓取网页上的信息,是最简单也最繁琐的实现方式,即获取模板的方法。从优采云采集器的配置过程来看,也是采用这种方式。就是这样,但是人们可以将抓取器做成成熟的产品并畅销。这是无与伦比的,所以它的成功并不完全取决于技术。虽然优采云采集器配置起来比较麻烦,但是看起来还是不错的。

这样,你需要制作一个模板。你需要知道目标网页的结构,知道你要找的信息在哪里,然后记录前后的字符串。您可以通过截取字符串来获取目标。也可以使用正则表达式获取信息。必须确保前后字符串是唯一的。这很简单。可以通过计算或者匹配的方式获取目标信息,但是在实践中还是存在一些问题:

下面是我遇到的问题;

1.首先想用正则表达式来匹配,但是模块中设置的前缀和后缀有回车换行\r\n,结果总是不成功。我的常规技能很差,终于知道怎么回事了,把\r\n换成(\s*),问题解决了,你能找出原因吗?

2. 使用字符串截取方式获取,不是很精通常规规则,使用这种方式最安全,但是在截取字符串之前,记得调整目标页面代码,前缀和从xml配置文件中读取的后缀中可能是回车和换行,但是回车和换行的字符行为在不同的系统中是不同的。在Windows中是\r\n,在Linux中是\n,所以记得统一。

3. 前缀和后缀不是唯一的。有时页面上有两个不同的目标信息,但它们具有相同的前缀,例如:

数据库

软件工程师

如果使用相同的前缀,拦截想要的信息会比较困难。我想到了一个办法。当然,方法可能很笨,但问题解决了。使用多个字符串定位Target信息也是优采云的启示,比如我要抓软件工程师,前缀是:

*

信息可能不同的地方用*替换,类似通配符。这样,用*把一个字符串一分为二,先找到第一个,然后以此索引位置为起点,再找到第二个字符串,这样就可以定位最终的信息,也可以用多个三个以上的字符串,这个实现就是为了解决问题,希望有更好的方法,希望以后能改进。

4. 你也可以在获取信息时使用 MITHtmlPparser。这是一个开源库。您可以在codeproject中找到它并分析网页中的所有标签。如果信息不是太多,它是非常零散的。,这个也比较好用,你只需要知道最终信息里面是哪个标签,然后直接拿出来就行了。

嗯,希望我能在新的一年多学点,经得起考验!

本站采用创意分享版权协议,要求签名,非商业性且一致。本站欢迎任何非商业用途的转载,但必须注明出自“发书”,保留原链接,同时必须注明原标题和链接。

标签:采集

php抓取网页匹配url(php抓取网页匹配url(地址)的javascript脚本支持)

网站优化 • 优采云 发表了文章 • 0 个评论 • 87 次浏览 • 2021-09-17 20:03

php抓取网页匹配url(地址)的javascript脚本支持cookie注册用户但是有些网站不会开启cookie注册功能无法连接本地浏览器进行记录网页爬取的时候方法很多不可一一列举

php+requests库也可以的,python有现成的爬虫工具scrapy、zope爬虫。也可以用pythoncrawl、scrapy+requests。

分析网页,然后取到url对应的地址,然后用javascript写一个获取url的脚本,

你可以试试这些方法,

python/http1.1

python可以爬。取得链接是最简单的方法。

可以用爬虫软件百度图片,

现在浏览器都支持对cookie,

python吧。

我也是学生,也正在学习爬虫,

谷歌浏览器:打开百度或者其他不提供浏览器的一方,他们也是不会带request服务器。

python可以用scrapy+requests库

以thomasbrewley和johnlemacey的文章为代表的大量教材已经在第一轮学习中给出答案了。题主可以搜索下详情。

python可以完成

非常简单的是使用requests库,不管是python在手还是在服务器端,requests永远是首选。

python有抓取程序库gevent,可以用来爬取twitter的推送(twitter的推送是百分百正确的网页,twitter貌似还会向ua注册者发送反爬虫通知,具体可以看网上的源码)。 查看全部

php抓取网页匹配url(php抓取网页匹配url(地址)的javascript脚本支持)

php抓取网页匹配url(地址)的javascript脚本支持cookie注册用户但是有些网站不会开启cookie注册功能无法连接本地浏览器进行记录网页爬取的时候方法很多不可一一列举

php+requests库也可以的,python有现成的爬虫工具scrapy、zope爬虫。也可以用pythoncrawl、scrapy+requests。

分析网页,然后取到url对应的地址,然后用javascript写一个获取url的脚本,

你可以试试这些方法,

python/http1.1

python可以爬。取得链接是最简单的方法。

可以用爬虫软件百度图片,

现在浏览器都支持对cookie,

python吧。

我也是学生,也正在学习爬虫,

谷歌浏览器:打开百度或者其他不提供浏览器的一方,他们也是不会带request服务器。

python可以用scrapy+requests库

以thomasbrewley和johnlemacey的文章为代表的大量教材已经在第一轮学习中给出答案了。题主可以搜索下详情。

python可以完成

非常简单的是使用requests库,不管是python在手还是在服务器端,requests永远是首选。

python有抓取程序库gevent,可以用来爬取twitter的推送(twitter的推送是百分百正确的网页,twitter貌似还会向ua注册者发送反爬虫通知,具体可以看网上的源码)。

php抓取网页匹配url(两种方法获取网站的meta信息,第一种方法是使用get )

网站优化 • 优采云 发表了文章 • 0 个评论 • 106 次浏览 • 2021-09-14 19:01

)

php获取网页元信息(包括标题、关键字、描述)的两种方法

时间:2016-06-23

在网页采集的过程中,我们需要获取网站的元信息,比如标题、关键词、描述等。这个文章介绍了两种获取网站元信息的方式,第一一种方法是使用get_meta_tags函数,第二种方法是使用正则表达式匹配的方法来获取。

使用 get_meta_tags 函数获取元信息

比如我们要获取这个网页的meta信息,可以直接使用php内置函数get_meta_tags来获取,代码如下:

结果输出:

使用正则表达式获取元信息

PHP代码如下:

<p>

$site = "http://www.manongjc.com";

$content = get_sitemeta($site);

print_r($content);

/** 获取META信息 */

function get_sitemeta($url) {

$data = file_get_contents($url);

$meta = array();

if (!empty($data)) {

#Title

preg_match('/([\w\W]*?)/si', $data, $matches);

if (!empty($matches[1])) {

$meta['title'] = $matches[1];

}

#Keywords

preg_match('/ 查看全部

php抓取网页匹配url(两种方法获取网站的meta信息,第一种方法是使用get

)

php获取网页元信息(包括标题、关键字、描述)的两种方法

时间:2016-06-23

在网页采集的过程中,我们需要获取网站的元信息,比如标题、关键词、描述等。这个文章介绍了两种获取网站元信息的方式,第一一种方法是使用get_meta_tags函数,第二种方法是使用正则表达式匹配的方法来获取。

使用 get_meta_tags 函数获取元信息

比如我们要获取这个网页的meta信息,可以直接使用php内置函数get_meta_tags来获取,代码如下:

结果输出:

使用正则表达式获取元信息

PHP代码如下:

<p>

$site = "http://www.manongjc.com";

$content = get_sitemeta($site);

print_r($content);

/** 获取META信息 */

function get_sitemeta($url) {

$data = file_get_contents($url);

$meta = array();

if (!empty($data)) {

#Title

preg_match('/([\w\W]*?)/si', $data, $matches);

if (!empty($matches[1])) {

$meta['title'] = $matches[1];

}

#Keywords

preg_match('/

php抓取网页匹配url(这是Python中的BeautifulSoup库(库)获取方法 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 112 次浏览 • 2021-09-14 09:05

)

您似乎在寻找 BeautifulSoup 库。这是 Python 中最流行的网页抓取库之一。你可以在这里找到项目页面:

首先需要获取要爬取的页面的HTML数据。这可以使用请求或库(例如 urllib)来完成。在下面的示例代码中,我使用的是请求库。

获取页面的HTML数据后,可以实例化BeautifulSoup对象,使用find_all方法指定要查找的URL,参数为“a”(因为HTML中的标签代表超链接),然后对于每个找到的 URL 的 href(超引用)执行成员资格测试,以测试特定单词是否在与该 URL 关联的 href 中。

import bs4

import requests

# Get the HTML data from the web page.

html = requests.get("https://www.google.com/").content

# Instantiate a BeautifulSoup object based on the HTML data.

soup = bs4.BeautifulSoup(html, "html.parser")

# Creating a list to store results in.

urlsContainingWord = []

# Get all the URLs in the page containing the word.

for url in soup.find_all("a"):

if "mail" in url["href"]:

urlsContainingWord.append(url)

# Print out the result.

print(urlsContainingWord)

在本例中,我要查找网络上所有收录“邮件”一词的 URL。我的输出如下所示:

[Gmail]

此外,如果您只需要 href 本身,您可以遍历列表并仅引用您找到的每个 URL 的 href。

for url in urlsContainingWord:

print(url["href"])

输出:

https://mail.google.com/mail/?tab=wm 查看全部

php抓取网页匹配url(这是Python中的BeautifulSoup库(库)获取方法

)

您似乎在寻找 BeautifulSoup 库。这是 Python 中最流行的网页抓取库之一。你可以在这里找到项目页面:

首先需要获取要爬取的页面的HTML数据。这可以使用请求或库(例如 urllib)来完成。在下面的示例代码中,我使用的是请求库。

获取页面的HTML数据后,可以实例化BeautifulSoup对象,使用find_all方法指定要查找的URL,参数为“a”(因为HTML中的标签代表超链接),然后对于每个找到的 URL 的 href(超引用)执行成员资格测试,以测试特定单词是否在与该 URL 关联的 href 中。

import bs4

import requests

# Get the HTML data from the web page.

html = requests.get("https://www.google.com/";).content

# Instantiate a BeautifulSoup object based on the HTML data.

soup = bs4.BeautifulSoup(html, "html.parser")

# Creating a list to store results in.

urlsContainingWord = []

# Get all the URLs in the page containing the word.

for url in soup.find_all("a"):

if "mail" in url["href"]:

urlsContainingWord.append(url)

# Print out the result.

print(urlsContainingWord)

在本例中,我要查找网络上所有收录“邮件”一词的 URL。我的输出如下所示:

[Gmail]

此外,如果您只需要 href 本身,您可以遍历列表并仅引用您找到的每个 URL 的 href。

for url in urlsContainingWord:

print(url["href"])

输出:

https://mail.google.com/mail/?tab=wm

php抓取网页匹配url(PHP正则表达式如何处理将要打开文件的标识和几种形式?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 128 次浏览 • 2021-09-12 21:08

我最近有一项任务是从页面中抓取页面上的所有链接。当然,使用 PHP 正则表达式是最方便的方式。要编写正则表达式,您必须首先总结模式。页面上的链接有多少个表单?

链接也是超链接,是从一个元素(文本、图像、视频等)到另一个元素(文本、图像、视频等)的链接。网页中的链接一般分为三种,一种是绝对网址超链接,即一个页面的完整路径;另一种是相对URL超链接,一般链接到同一网站的其他页面;另一个是页面内的超链接,这通常链接到同一页面内的其他位置。

了解链接的种类就知道要抓取链接,主要是绝对网址超链接和相对网址超链接。要写出正确的正则表达式,我们必须了解我们正在寻找的对象的模式。

先说绝对链接,也叫URL(Uniform Resource Locator),它标识了互联网上唯一的资源。 URL结构由三部分组成:协议、服务器名、路径和文件名。

该协议告诉浏览器如何处理要打开的文件的标识符,最常见的是http协议。本文也只考虑 HTTP 协议。至于其他的https、ftp、mailto、telnet等,可以根据需要自行添加。

服务器名称是告诉浏览器如何到达这个服务器的方式。通常是域名或IP地址,有时会收录端口号(默认为80)。在FTP协议中,也可以收录用户名和密码,我不考虑。

路径和文件名,通常用/分隔,表示文件的路径和文件本身的名称。如果没有具体的文件名,则访问该文件夹下的默认文件(可以在服务器端设置)。

到此就明白了,典型的绝对链接被爬取的形式可以概括为

每个部分可以使用的字符范围都有明确的规范。详情请参考RFC1738。那么正则表达式就可以写出来了。 查看全部

php抓取网页匹配url(PHP正则表达式如何处理将要打开文件的标识和几种形式?)

我最近有一项任务是从页面中抓取页面上的所有链接。当然,使用 PHP 正则表达式是最方便的方式。要编写正则表达式,您必须首先总结模式。页面上的链接有多少个表单?

链接也是超链接,是从一个元素(文本、图像、视频等)到另一个元素(文本、图像、视频等)的链接。网页中的链接一般分为三种,一种是绝对网址超链接,即一个页面的完整路径;另一种是相对URL超链接,一般链接到同一网站的其他页面;另一个是页面内的超链接,这通常链接到同一页面内的其他位置。

了解链接的种类就知道要抓取链接,主要是绝对网址超链接和相对网址超链接。要写出正确的正则表达式,我们必须了解我们正在寻找的对象的模式。

先说绝对链接,也叫URL(Uniform Resource Locator),它标识了互联网上唯一的资源。 URL结构由三部分组成:协议、服务器名、路径和文件名。

该协议告诉浏览器如何处理要打开的文件的标识符,最常见的是http协议。本文也只考虑 HTTP 协议。至于其他的https、ftp、mailto、telnet等,可以根据需要自行添加。

服务器名称是告诉浏览器如何到达这个服务器的方式。通常是域名或IP地址,有时会收录端口号(默认为80)。在FTP协议中,也可以收录用户名和密码,我不考虑。

路径和文件名,通常用/分隔,表示文件的路径和文件本身的名称。如果没有具体的文件名,则访问该文件夹下的默认文件(可以在服务器端设置)。

到此就明白了,典型的绝对链接被爬取的形式可以概括为

每个部分可以使用的字符范围都有明确的规范。详情请参考RFC1738。那么正则表达式就可以写出来了。

php抓取网页匹配url(php抓取网页匹配url中的参数方法if(..))

网站优化 • 优采云 发表了文章 • 0 个评论 • 80 次浏览 • 2021-11-27 14:03

php抓取网页匹配url中的参数方法if(...){try{postmessage({url:":8080/",postid:"aleban",secure:true});}catch(exceptione){e.printstacktrace();}

这个我都会答,关注公众号:python爬虫开发,

换一种post方式,"aleban"是只针对我公众号的,其他不受影响。

把你想访问的页面用抓包工具抓包,

提供几个思路:

1、运行爬虫,得到domcookie,这个一般是浏览器抓包工具才有,比如postman,对于部分库来说并不适用。抓取的数据要进行保存和处理,比如设置时间戳发送等等。

2、可以把抓取的数据,像json、html等格式转换成javascript代码,如gson、webdriver、mathjax等。

3、对于某些固定url,可以定期抓取,使用beautifulsoup等模块直接拿到数据。

带参数的url,使用preparedefined方法。

爬虫的一般解决方法

现在我发现一个非常强大的工具threejs,本地就可以爬取各种网站的特定页面:

awesomepythonwebscrapingwithpreparedefinedurls

1.使用相关库,

urllib2,requests 查看全部

php抓取网页匹配url(php抓取网页匹配url中的参数方法if(..))

php抓取网页匹配url中的参数方法if(...){try{postmessage({url:":8080/",postid:"aleban",secure:true});}catch(exceptione){e.printstacktrace();}

这个我都会答,关注公众号:python爬虫开发,

换一种post方式,"aleban"是只针对我公众号的,其他不受影响。

把你想访问的页面用抓包工具抓包,

提供几个思路:

1、运行爬虫,得到domcookie,这个一般是浏览器抓包工具才有,比如postman,对于部分库来说并不适用。抓取的数据要进行保存和处理,比如设置时间戳发送等等。

2、可以把抓取的数据,像json、html等格式转换成javascript代码,如gson、webdriver、mathjax等。

3、对于某些固定url,可以定期抓取,使用beautifulsoup等模块直接拿到数据。

带参数的url,使用preparedefined方法。

爬虫的一般解决方法

现在我发现一个非常强大的工具threejs,本地就可以爬取各种网站的特定页面:

awesomepythonwebscrapingwithpreparedefinedurls

1.使用相关库,

urllib2,requests

php抓取网页匹配url(最佳答案,正则匹配部分新闻内容存入数组,该怎么做呢?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 70 次浏览 • 2021-11-24 13:10

最佳答案

我是php新手,现在想用c***l抓取学校网页,把新闻内容的正则匹配部分存放在数组中。我该怎么办?以下为官网部分主要代码。我想在开始时抓取内容。可以通过常规匹配来实现吗?再问一下,PHP的正则匹配是用PCRE实现的还是什么的?网上这部分的知识好乱,求大神

首先c***l不是这样使用的,需要先初始化c***l_init,然后需要使用c***l_setopt来设置你请求的参数和设置。最后通过c***l_exec执行请求。

返回的结果必须是网页的完整源代码。如果要从中提取信息,就得看好目标位置是否有唯一标识,也就是能否准确定位到自己需要的位置。然后使用正则匹配。你上面只给了一个td。如果确实可以保证这个 td(加上它的属性)是你想要的数据,那么它可以是正则的。

这很简单

/

]+>(.*)/

跟进:

非常满意。你能解释一下这个符号的含义吗?另外,我看到已经匹配并存储了一个数组,但我看不到它。请问如何再次输出。

回复:

/ 的左右两边是分隔的,不需要解释。[^>] 是匹配除 > 之外的任何字符。+ 是匹配前面括号的内容一次或多次。(.*) 匹配任意数量的字符。当然,你可能需要改成(.*?)来实现非贪婪匹配,即匹配到最近的时

在时间停止当前匹配以继续下一轮匹配(因为您正在使用 match_all 函数)。括号表示分组,所以这个分组会记录在列表结果中,$list[1]就是这个分组的数据。 查看全部

php抓取网页匹配url(最佳答案,正则匹配部分新闻内容存入数组,该怎么做呢?)

最佳答案

我是php新手,现在想用c***l抓取学校网页,把新闻内容的正则匹配部分存放在数组中。我该怎么办?以下为官网部分主要代码。我想在开始时抓取内容。可以通过常规匹配来实现吗?再问一下,PHP的正则匹配是用PCRE实现的还是什么的?网上这部分的知识好乱,求大神

首先c***l不是这样使用的,需要先初始化c***l_init,然后需要使用c***l_setopt来设置你请求的参数和设置。最后通过c***l_exec执行请求。

返回的结果必须是网页的完整源代码。如果要从中提取信息,就得看好目标位置是否有唯一标识,也就是能否准确定位到自己需要的位置。然后使用正则匹配。你上面只给了一个td。如果确实可以保证这个 td(加上它的属性)是你想要的数据,那么它可以是正则的。

这很简单

/

]+>(.*)/

跟进:

非常满意。你能解释一下这个符号的含义吗?另外,我看到已经匹配并存储了一个数组,但我看不到它。请问如何再次输出。

回复:

/ 的左右两边是分隔的,不需要解释。[^>] 是匹配除 > 之外的任何字符。+ 是匹配前面括号的内容一次或多次。(.*) 匹配任意数量的字符。当然,你可能需要改成(.*?)来实现非贪婪匹配,即匹配到最近的时

在时间停止当前匹配以继续下一轮匹配(因为您正在使用 match_all 函数)。括号表示分组,所以这个分组会记录在列表结果中,$list[1]就是这个分组的数据。

php抓取网页匹配url(php抓取网页匹配url等缓存系统缓存用户缓存机制在哪个时间点有用访问量修改虚拟内存可以修改对象可以基于泛型)

网站优化 • 优采云 发表了文章 • 0 个评论 • 73 次浏览 • 2021-11-23 19:04

php抓取网页匹配url抓取网页内容redisd等缓存系统缓存用户缓存机制在哪个时间点有用访问量修改虚拟内存可以修改对象可以基于泛型使用getter/setter方法来定制时序。html/css等不推荐使用全局变量限制sql语句范围小型系统一个提示图。nodejs本身是可以用co,redisd等缓存系统作为宿主。

你可以选择一个你感兴趣的。php可以使用getsavemessage,redisd可以使用ci工作并且使用redisd代码可以直接拿出来部署。

用php一直在琢磨bootstrap。对于初学者,mvc的使用会是遇到的最多的问题之一。然后还可以看下thinkphp,写过一些感觉效果还不错。

可以用php构建微型系统,php-fpm或erlang-fi。即嵌入工具,在客户端,只要是可以达到php语言规范的语言语法,在服务端,完全符合erlang语言规范。这两种语言在php中都已经被大量使用,而且自己没有readability,tree等限制。

我觉得想要拿好工资就去拼linux开发,还有phplinux环境等等,去创业公司,

cs与bios无缝嵌入;学会虚拟机可以开发类似runtime模拟windows。说直白点,就是找到超级简单的中间层,

找个自己真正感兴趣的点, 查看全部

php抓取网页匹配url(php抓取网页匹配url等缓存系统缓存用户缓存机制在哪个时间点有用访问量修改虚拟内存可以修改对象可以基于泛型)

php抓取网页匹配url抓取网页内容redisd等缓存系统缓存用户缓存机制在哪个时间点有用访问量修改虚拟内存可以修改对象可以基于泛型使用getter/setter方法来定制时序。html/css等不推荐使用全局变量限制sql语句范围小型系统一个提示图。nodejs本身是可以用co,redisd等缓存系统作为宿主。

你可以选择一个你感兴趣的。php可以使用getsavemessage,redisd可以使用ci工作并且使用redisd代码可以直接拿出来部署。

用php一直在琢磨bootstrap。对于初学者,mvc的使用会是遇到的最多的问题之一。然后还可以看下thinkphp,写过一些感觉效果还不错。

可以用php构建微型系统,php-fpm或erlang-fi。即嵌入工具,在客户端,只要是可以达到php语言规范的语言语法,在服务端,完全符合erlang语言规范。这两种语言在php中都已经被大量使用,而且自己没有readability,tree等限制。

我觉得想要拿好工资就去拼linux开发,还有phplinux环境等等,去创业公司,

cs与bios无缝嵌入;学会虚拟机可以开发类似runtime模拟windows。说直白点,就是找到超级简单的中间层,

找个自己真正感兴趣的点,

php抓取网页匹配url(PythonDjangoDjango应用投票)

网站优化 • 优采云 发表了文章 • 0 个评论 • 89 次浏览 • 2021-11-18 23:18

编写您的第一个 Django 应用程序,第 1 部分

让我们以身作则。

通过本教程,我们将带您创建一个基本的投票应用程序。

它将由两部分组成:

我们假设您已经阅读了有关安装 Django 的内容。在命令提示符下输入命令(以$为前缀)就可以知道Django已经安装完毕以及安装的是哪个版本。

$ python -m django --version

...\> py -m django --version

如果这行命令输出一个版本号,则证明你已经安装了这个版本的Django;如果您收到“No module named django”错误消息,则表示您尚未安装它。

本教程是为 Django 3.2 编写的,支持 Python 3.6 及后续版本。如果Django版本不匹配,您可以通过页面右下角的版本切换器切换到您版本对应的教程,或者更新到最新版本。如果您使用的是旧版本的 Python,请寻找合适的 Django 版本。

您可以查看文档 How to Install Django 以获取删除旧版本和安装新版本的过程和建议。

从哪里获得帮助:

如果您在阅读本教程时有任何疑问,可以转到常见问题部分寻求帮助。

创建项目

如果这是您第一次使用 Django,则需要一些初始设置。换句话说,你需要用一些自动生成的代码来配置一个 Django——即一个 Django 项目实例所需的设置集合,包括数据库配置、Django 配置和应用程序配置。

打开命令行,cd 到要放置代码的目录,然后运行以下命令:

$ django-admin startproject mysite

...\> django-admin startproject mysite

这行代码将在当前目录中创建一个 mysite 目录。如果命令失败,请检查它,它可能会帮助您。

注解

您必须避免使用 Python 或 Django 的内部保留字来命名您的项目。具体来说,您必须避免使用 django(与 Django 本身冲突)或 test(与 Python 的内置组件冲突)之类的名称。

我应该把代码放在哪里?

如果您曾经是 PHP 原生程序员(从未使用过现代框架),您可能习惯于将代码放在 Web 服务器的文档根目录中(例如 /var/www)。这在使用 Django 时不是必需的。将所有 Python 代码放在 Web 服务器的根目录中并不是一个好主意,因为它有风险。例如,它会增加人们在 网站 上看到您的代码的可能性。这不利于网站的安全。

将您的代码放在文档根目录以外的其他位置,例如 /home/mycode。

让我们看看创建了什么:

mysite/

manage.py

mysite/

__init__.py

settings.py

urls.py

asgi.py

wsgi.py

这些目录和文件的用处是:

用于开发的简单服务器

我们来确认一下你的Django项目是否真的创建成功。如果当前目录不是mysite外目录,请切换到该目录,然后运行以下命令:

$ python manage.py runserver

...\> py manage.py runserver

您应该看到以下输出:

Performing system checks...

System check identified no issues (0 silenced).

You have unapplied migrations; your app may not work properly until they are applied.

Run 'python manage.py migrate' to apply them.

十一月 18, 2021 - 15:50:53

Django version 3.2, using settings 'mysite.settings'

Starting development server at http://127.0.0.1:8000/

Quit the server with CONTROL-C.

注解

忽略不应用最新数据库迁移的警告,我们稍后会处理数据库。

你刚刚开始的是Django自带的用于开发的简单服务器。它是一个用纯 Python 编写的轻量级 Web 服务器。我们将这个服务器内置到 Django 中,以便您可以快速开发您想要的东西,因为您不需要配置生产级服务器(例如 Apache),除非您准备将其放入生产环境。

现在是提醒您的好时机:切勿在任何与生产环境相关的地方使用此服务器。此服务器仅用于开发。(我们是网络框架方面的专家,但不是网络服务器方面的专家。)

现在,服务器正在运行,浏览器访问:8000/。您将看到一个“祝贺”页面,并且随着火箭发射,服务器已经在运行。

更换端口

默认情况下,该命令会将服务器设置为侦听机器内部 IP 的 8000 端口。

如果要更改服务器的监听端口,请使用命令行参数。例如,以下命令将使服务器侦听端口 8080:

$ python manage.py runserver 8080

...\> py manage.py runserver 8080

如果要更改服务器侦听的IP,请在端口前输入新的IP。例如,为了监控所有服务器的公共 IP(这在您运行 Vagrant 或想要向网络上的其他计算机显示您的结果时很有用),请使用:

$ python manage.py runserver 0:8000

...\> py manage.py runserver 0:8000

0 是 0.0.0.0 的缩写。可以在参考文档中找到有关开发服务器的完整文档。

一个会自动重新加载的服务器

如果需要,用于开发的服务器将为每个访问请求重新加载 Python 代码。因此,您无需频繁重启服务器即可使修改后的代码生效。但是,某些操作(例如添加新文件)不会触发自动重新加载,在这种情况下您必须手动重新启动服务器。

创建投票应用

现在你的开发环境——这个“项目”——已经配置好了,你可以开始工作了。

在 Django 中,每个应用程序都是一个 Python 包并遵循相同的约定。Django 附带了一个工具,可以帮助您生成应用程序的基本目录结构,因此您可以专注于编写代码而不是创建目录。

项目 VS 应用

项目和应用程序有什么区别?应用程序是专门用于执行某些操作的 Web 应用程序,例如博客系统、公共记录数据库或小型投票程序。该项目是 网站 使用的配置和应用程序的集合。该项目可以收录许多应用程序。该应用程序可用于许多项目。

您的应用程序可以存储在定义的任何路径中。在本教程中,我们将在与您的 manage.py 相同的目录中创建一个投票应用程序。通过这种方式,它可以作为顶级模块而不是 mysite 的子模块导入。

确保您与 manage.py 位于同一目录中,然后运行此命令以创建应用程序:

$ python manage.py startapp polls

...\> py manage.py startapp polls

这将创建一个 polls 目录,其目录结构大致如下:

polls/

__init__.py

admin.py

apps.py

migrations/

__init__.py

models.py

tests.py

views.py

此目录结构收录投票应用程序的所有内容。

写第一个视图

让我们开始编写第一个视图。打开 polls/views.py 并输入以下 Python 代码:

民意调查/views.py

from django.http import HttpResponse

def index(request):

return HttpResponse("Hello, world. You're at the polls index.")

这是 Django 中最简单的视图。如果我们想看到效果,我们需要将一个 URL 映射到它——这就是我们需要 URLconf 的原因。

为了创建 URLconf,请在 polls 目录中创建一个新的 urls.py 文件。您的应用程序目录现在应如下所示:

polls/

__init__.py

admin.py

apps.py

migrations/

__init__.py

models.py

tests.py

urls.py

views.py

在 polls/urls.py 中,输入以下代码:

民意调查/网址.py

from django.urls import path

from . import views

urlpatterns = [

path('', views.index, name='index'),

]

下一步是指定我们在根 URLconf 文件中创建的 polls.urls 模块。在mysite/urls.py文件的urlpatterns列表中插入一个include(),如下:

我的网站/urls.py

from django.contrib import admin

from django.urls import include, path

urlpatterns = [

path('polls/', include('polls.urls')),

path('admin/', admin.site.urls),

]

该函数允许引用其他 URLconf。每当 Django 遇到它时,它都会截断 URL 中与此项匹配的部分,并将剩余的字符串发送到 URLconf 以进行进一步处理。

我们的设计理念是即插即用。因为投票应用程序有自己的 URLconf (polls/urls.py),它们可以放置在“/polls/”、“/fun_polls/”、“/content/polls/”或任何其他路径中。可以正常工作。

何时使用

在收录其他 URL 模式时,您应该始终使用 include(),admin.site.urls 是唯一的例外。

您现在已将索引视图添加到 URLconf。使用以下命令验证它是否正常工作:

$ python manage.py runserver

...\> py manage.py runserver

使用浏览器访问:8000/polls/,应该可以看到“Hello, world. You're at the polls index.”,在index视图中定义。

没有找到页面?

如果您在此处看到错误页面,请检查您是否正在访问 :8000/polls/ 而不是 :8000/。

该函数有四个参数,两个必需参数:route 和 view,以及两个可选参数:kwargs 和 name。现在,是时候研究这些参数的含义了。

参数:路由

route 是匹配 URL 的标准(类似于正则表达式)。当 Django 响应请求时,它会从 urlpatterns 的第一项开始,依次匹配列表中的项,直到找到匹配项。

这些条件将不匹配 GET 和 POST 参数或域名。例如,当 URLconf 处理请求时,它会尝试匹配 myapp/。在处理请求时,它只会尝试匹配 myapp/。

参数:查看

当 Django 找到匹配条件时,它会调用这个特定的视图函数并传入一个对象作为第一个参数。“捕获的”参数作为关键字参数传入。我们稍后会举一个例子。

参数:kwargs

可以将任意数量的关键字参数作为字典传递给目标视图函数。本教程将不使用此功能。

参数:名称

命名你的 URL 允许你在 Django 的任何地方唯一地引用它,尤其是在模板中。这一有用的功能允许您通过仅更改一个文件来全局修改 URL 模式。

在您了解基本的请求和响应过程后,请阅读教程的第 2 部分以开始使用数据库。 查看全部

php抓取网页匹配url(PythonDjangoDjango应用投票)

编写您的第一个 Django 应用程序,第 1 部分

让我们以身作则。

通过本教程,我们将带您创建一个基本的投票应用程序。

它将由两部分组成:

我们假设您已经阅读了有关安装 Django 的内容。在命令提示符下输入命令(以$为前缀)就可以知道Django已经安装完毕以及安装的是哪个版本。

$ python -m django --version

...\> py -m django --version

如果这行命令输出一个版本号,则证明你已经安装了这个版本的Django;如果您收到“No module named django”错误消息,则表示您尚未安装它。

本教程是为 Django 3.2 编写的,支持 Python 3.6 及后续版本。如果Django版本不匹配,您可以通过页面右下角的版本切换器切换到您版本对应的教程,或者更新到最新版本。如果您使用的是旧版本的 Python,请寻找合适的 Django 版本。

您可以查看文档 How to Install Django 以获取删除旧版本和安装新版本的过程和建议。

从哪里获得帮助:

如果您在阅读本教程时有任何疑问,可以转到常见问题部分寻求帮助。

创建项目

如果这是您第一次使用 Django,则需要一些初始设置。换句话说,你需要用一些自动生成的代码来配置一个 Django——即一个 Django 项目实例所需的设置集合,包括数据库配置、Django 配置和应用程序配置。

打开命令行,cd 到要放置代码的目录,然后运行以下命令:

$ django-admin startproject mysite

...\> django-admin startproject mysite

这行代码将在当前目录中创建一个 mysite 目录。如果命令失败,请检查它,它可能会帮助您。

注解

您必须避免使用 Python 或 Django 的内部保留字来命名您的项目。具体来说,您必须避免使用 django(与 Django 本身冲突)或 test(与 Python 的内置组件冲突)之类的名称。

我应该把代码放在哪里?

如果您曾经是 PHP 原生程序员(从未使用过现代框架),您可能习惯于将代码放在 Web 服务器的文档根目录中(例如 /var/www)。这在使用 Django 时不是必需的。将所有 Python 代码放在 Web 服务器的根目录中并不是一个好主意,因为它有风险。例如,它会增加人们在 网站 上看到您的代码的可能性。这不利于网站的安全。

将您的代码放在文档根目录以外的其他位置,例如 /home/mycode。

让我们看看创建了什么:

mysite/

manage.py

mysite/

__init__.py

settings.py

urls.py

asgi.py

wsgi.py

这些目录和文件的用处是:

用于开发的简单服务器

我们来确认一下你的Django项目是否真的创建成功。如果当前目录不是mysite外目录,请切换到该目录,然后运行以下命令:

$ python manage.py runserver

...\> py manage.py runserver

您应该看到以下输出:

Performing system checks...

System check identified no issues (0 silenced).

You have unapplied migrations; your app may not work properly until they are applied.

Run 'python manage.py migrate' to apply them.

十一月 18, 2021 - 15:50:53

Django version 3.2, using settings 'mysite.settings'

Starting development server at http://127.0.0.1:8000/

Quit the server with CONTROL-C.

注解

忽略不应用最新数据库迁移的警告,我们稍后会处理数据库。

你刚刚开始的是Django自带的用于开发的简单服务器。它是一个用纯 Python 编写的轻量级 Web 服务器。我们将这个服务器内置到 Django 中,以便您可以快速开发您想要的东西,因为您不需要配置生产级服务器(例如 Apache),除非您准备将其放入生产环境。

现在是提醒您的好时机:切勿在任何与生产环境相关的地方使用此服务器。此服务器仅用于开发。(我们是网络框架方面的专家,但不是网络服务器方面的专家。)

现在,服务器正在运行,浏览器访问:8000/。您将看到一个“祝贺”页面,并且随着火箭发射,服务器已经在运行。

更换端口

默认情况下,该命令会将服务器设置为侦听机器内部 IP 的 8000 端口。

如果要更改服务器的监听端口,请使用命令行参数。例如,以下命令将使服务器侦听端口 8080:

$ python manage.py runserver 8080

...\> py manage.py runserver 8080

如果要更改服务器侦听的IP,请在端口前输入新的IP。例如,为了监控所有服务器的公共 IP(这在您运行 Vagrant 或想要向网络上的其他计算机显示您的结果时很有用),请使用:

$ python manage.py runserver 0:8000

...\> py manage.py runserver 0:8000

0 是 0.0.0.0 的缩写。可以在参考文档中找到有关开发服务器的完整文档。

一个会自动重新加载的服务器

如果需要,用于开发的服务器将为每个访问请求重新加载 Python 代码。因此,您无需频繁重启服务器即可使修改后的代码生效。但是,某些操作(例如添加新文件)不会触发自动重新加载,在这种情况下您必须手动重新启动服务器。

创建投票应用

现在你的开发环境——这个“项目”——已经配置好了,你可以开始工作了。

在 Django 中,每个应用程序都是一个 Python 包并遵循相同的约定。Django 附带了一个工具,可以帮助您生成应用程序的基本目录结构,因此您可以专注于编写代码而不是创建目录。

项目 VS 应用

项目和应用程序有什么区别?应用程序是专门用于执行某些操作的 Web 应用程序,例如博客系统、公共记录数据库或小型投票程序。该项目是 网站 使用的配置和应用程序的集合。该项目可以收录许多应用程序。该应用程序可用于许多项目。

您的应用程序可以存储在定义的任何路径中。在本教程中,我们将在与您的 manage.py 相同的目录中创建一个投票应用程序。通过这种方式,它可以作为顶级模块而不是 mysite 的子模块导入。

确保您与 manage.py 位于同一目录中,然后运行此命令以创建应用程序:

$ python manage.py startapp polls

...\> py manage.py startapp polls

这将创建一个 polls 目录,其目录结构大致如下:

polls/

__init__.py

admin.py

apps.py

migrations/

__init__.py

models.py

tests.py

views.py

此目录结构收录投票应用程序的所有内容。

写第一个视图

让我们开始编写第一个视图。打开 polls/views.py 并输入以下 Python 代码:

民意调查/views.py

from django.http import HttpResponse

def index(request):

return HttpResponse("Hello, world. You're at the polls index.")

这是 Django 中最简单的视图。如果我们想看到效果,我们需要将一个 URL 映射到它——这就是我们需要 URLconf 的原因。

为了创建 URLconf,请在 polls 目录中创建一个新的 urls.py 文件。您的应用程序目录现在应如下所示:

polls/

__init__.py

admin.py

apps.py

migrations/

__init__.py

models.py

tests.py

urls.py

views.py

在 polls/urls.py 中,输入以下代码:

民意调查/网址.py

from django.urls import path

from . import views

urlpatterns = [

path('', views.index, name='index'),

]

下一步是指定我们在根 URLconf 文件中创建的 polls.urls 模块。在mysite/urls.py文件的urlpatterns列表中插入一个include(),如下:

我的网站/urls.py

from django.contrib import admin

from django.urls import include, path

urlpatterns = [

path('polls/', include('polls.urls')),

path('admin/', admin.site.urls),

]

该函数允许引用其他 URLconf。每当 Django 遇到它时,它都会截断 URL 中与此项匹配的部分,并将剩余的字符串发送到 URLconf 以进行进一步处理。

我们的设计理念是即插即用。因为投票应用程序有自己的 URLconf (polls/urls.py),它们可以放置在“/polls/”、“/fun_polls/”、“/content/polls/”或任何其他路径中。可以正常工作。

何时使用

在收录其他 URL 模式时,您应该始终使用 include(),admin.site.urls 是唯一的例外。

您现在已将索引视图添加到 URLconf。使用以下命令验证它是否正常工作:

$ python manage.py runserver

...\> py manage.py runserver

使用浏览器访问:8000/polls/,应该可以看到“Hello, world. You're at the polls index.”,在index视图中定义。

没有找到页面?

如果您在此处看到错误页面,请检查您是否正在访问 :8000/polls/ 而不是 :8000/。

该函数有四个参数,两个必需参数:route 和 view,以及两个可选参数:kwargs 和 name。现在,是时候研究这些参数的含义了。

参数:路由

route 是匹配 URL 的标准(类似于正则表达式)。当 Django 响应请求时,它会从 urlpatterns 的第一项开始,依次匹配列表中的项,直到找到匹配项。

这些条件将不匹配 GET 和 POST 参数或域名。例如,当 URLconf 处理请求时,它会尝试匹配 myapp/。在处理请求时,它只会尝试匹配 myapp/。

参数:查看

当 Django 找到匹配条件时,它会调用这个特定的视图函数并传入一个对象作为第一个参数。“捕获的”参数作为关键字参数传入。我们稍后会举一个例子。

参数:kwargs

可以将任意数量的关键字参数作为字典传递给目标视图函数。本教程将不使用此功能。

参数:名称

命名你的 URL 允许你在 Django 的任何地方唯一地引用它,尤其是在模板中。这一有用的功能允许您通过仅更改一个文件来全局修改 URL 模式。

在您了解基本的请求和响应过程后,请阅读教程的第 2 部分以开始使用数据库。

php抓取网页匹配url(循环读取流中的每一行字符,取得email的详细内容)

网站优化 • 优采云 发表了文章 • 0 个评论 • 90 次浏览 • 2021-11-18 10:01

4、 循环读取流中的每一行数据,Pattern 对象编译的正则表达式匹配每一行字符,获取邮件地址

这是我们的代码:

package cn.bdqn; import java.io.BufferedReader; import java.io.IOException; import java.io.InputStreamReader; //和网络相关的操作 import java.net.URL; import java.net.URLConnection; import java.util.regex.Matcher; import java.util.regex.Pattern; /** * 正则抓取邮箱 * @author happy * */ public class Test { public static void main(String[] args) throws IOException { //1.1 创建一个url对象 URL url = new URL("https://www.douban.com/group/topic/8845032/"); //1.2 打开连接 URLConnection conn = url.openConnection(); //1.3 设置连接网络超时时间 单位为毫秒 conn.setConnectTimeout(1000 * 10); //1.4 通过流 操作读取指定网络地址中的文件 BufferedReader bufr = new BufferedReader(new InputStreamReader(conn.getInputStream())); String line = null; //1.5 匹配email的正则 String regex = "[a-zA-Z0-9_-]+@\\w+\\.[a-z]+(\\.[a-z]+)?"; //1.6 使用模式的compile()方法生成模式对象 Pattern p = Pattern.compile(regex); //1. while((line = bufr.readLine()) != null) { Matcher m = p.matcher(line); while(m.find()) { System.out.println(m.group());// 获得匹配的email } } } }

这里主要是使用正则来匹配邮箱:

字符串正则表达式 = "[a-zA-Z0-9_-]+@\\w+\\.[az]+(\\.[az]+)?";

[a-zA-Z0-9_-] 只能收录字母、数字、下划线和减号。“+”表示匹配 [a-zA-Z0-9_-] 一次或多次。@后面可以出现任何非单字符,相当于[^a-zA-Z0-9_],可以重复一次或多次,结束后必须有\。被转义,然后点击后,可以出现a和z之间的任何字符。

捕获的结果如下:

以上就是java使用正则抓取webmail的详细内容,请关注其他相关html中文网站文章! 查看全部

php抓取网页匹配url(循环读取流中的每一行字符,取得email的详细内容)

4、 循环读取流中的每一行数据,Pattern 对象编译的正则表达式匹配每一行字符,获取邮件地址

这是我们的代码:

package cn.bdqn; import java.io.BufferedReader; import java.io.IOException; import java.io.InputStreamReader; //和网络相关的操作 import java.net.URL; import java.net.URLConnection; import java.util.regex.Matcher; import java.util.regex.Pattern; /** * 正则抓取邮箱 * @author happy * */ public class Test { public static void main(String[] args) throws IOException { //1.1 创建一个url对象 URL url = new URL("https://www.douban.com/group/topic/8845032/";); //1.2 打开连接 URLConnection conn = url.openConnection(); //1.3 设置连接网络超时时间 单位为毫秒 conn.setConnectTimeout(1000 * 10); //1.4 通过流 操作读取指定网络地址中的文件 BufferedReader bufr = new BufferedReader(new InputStreamReader(conn.getInputStream())); String line = null; //1.5 匹配email的正则 String regex = "[a-zA-Z0-9_-]+@\\w+\\.[a-z]+(\\.[a-z]+)?"; //1.6 使用模式的compile()方法生成模式对象 Pattern p = Pattern.compile(regex); //1. while((line = bufr.readLine()) != null) { Matcher m = p.matcher(line); while(m.find()) { System.out.println(m.group());// 获得匹配的email } } } }

这里主要是使用正则来匹配邮箱:

字符串正则表达式 = "[a-zA-Z0-9_-]+@\\w+\\.[az]+(\\.[az]+)?";

[a-zA-Z0-9_-] 只能收录字母、数字、下划线和减号。“+”表示匹配 [a-zA-Z0-9_-] 一次或多次。@后面可以出现任何非单字符,相当于[^a-zA-Z0-9_],可以重复一次或多次,结束后必须有\。被转义,然后点击后,可以出现a和z之间的任何字符。

捕获的结果如下:

以上就是java使用正则抓取webmail的详细内容,请关注其他相关html中文网站文章!

php抓取网页匹配url( 一下格式文件介绍一下模块中的几个简单功能(图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 78 次浏览 • 2021-11-18 09:21

一下格式文件介绍一下模块中的几个简单功能(图))

Python使用re正则表达式抢豆瓣电影Top250排名

使用 request 和 re 获取电影名称、电影年份、电影评分和电影排名的评论人数,并将它们写为 .csv 文件

先介绍一下re模块中的几个简单常用的方法

重新模块

几个简单的功能

1. findall

# findall :匹配字符串中所有符合正则的内容

import re

result = re.findall(r"\d+", "你好我的电话是123456,他的电话是654321")

print(result)

>>>['123456', '654321']

2. 查找器

# finditer :匹配字符串中所有的内容(返回迭代器)

result2 = re.finditer(r"\d+", "你好我的电话是123456,他的电话是654321")

for i in result2:#从迭代器中取数据

print(i)

>>>

>>>

for i in result2:#从迭代器中取数据

print(i.group()) #使用group()方法直接输出match到的数据

>>>123456

>>>654321

3.搜索

#search 只要找到一个结果就返回match对象,需要使用group()方法取数据

result3 = re.search(r"\d+", "你好我的电话是123456,他的电话是654321")

print(result3.group())

>>>123456

print(result3.group())

>>>123456#不会继续往后找

4.匹配