php抓取网页匹配url

php抓取网页匹配url(区分和搞清楚每个函数真正的用处-乐题库)

网站优化 • 优采云 发表了文章 • 0 个评论 • 78 次浏览 • 2022-02-10 13:00

在日常业务开发过程中,我们经常会有处理URL链接的需求,所以今天学习的功能其实是大家经常用到的一些功能。在之前的工作过程中,其实我对这些功能只是一个模糊的概念,我知道,但是当我真的需要使用它的时候,我还是需要阅读文档来确定我真正要使用哪个功能。因此,今天我们将其作为一个复习练习,主要是为了区分和弄清楚每个功能的真实用途。

编码运算函数

首先要看的是与 URL 编码相关的函数。有些浏览器会在我们复制粘贴后自动对 URL 进行 URL 编码,也就是很多百分号的形式。在 PHP 中,也有相应的编解码器函数。

$url = "https://www.zyblog.net%3Fopt%3 ... 3Daaa bbb ccc %dfg &==*() cdg&value=“中文也有呀,还有中文符号!!”";

echo $url, PHP_EOL;

// https://www.zyblog.net%3Fopt%3 ... 3Daaa bbb ccc %dfg &==*() cdg&value=“中文也有呀,还有中文符号!!”

$enurl = urlencode($url);

echo $enurl, PHP_EOL;

// https%3A%2F%2Fwww.zyblog.net%3Fopt%3Ddev%26mail%3Dzyblog%40net.net%26comments%3Daaa+bbb+ccc+%25dfg+%26%3D%3D%2A%28%29+cdg%26value%3D%E2%80%9C%E4%B8%AD%E6%96%87%E4%B9%9F%E6%9C%89%E5%91%80%EF%BC%8C%E8%BF%98%E6%9C%89%E4%B8%AD%E6%96%87%E7%AC%A6%E5%8F%B7%EF%BC%81%EF%BC%81%E2%80%9D

echo urldecode($enurl), PHP_EOL;

// https://www.zyblog.net%3Fopt%3 ... 3Daaa bbb ccc %dfg &==*() cdg&value=“中文也有呀,还有中文符号!!”

这两个函数估计是最常用的函数。urlencode() 是 URL 的编码操作。如您所见,我们准备的链接已被编码为收录各种百分号的内容。尤其是汉字,如果链接中的中文参数是GET方法,编码后的内容会使链接很长。urldecode() 是对应解码函数的函数,可以将编码后的链接解码回原来的状态。

$rawenurl = rawurlencode($enurl);

echo $rawenurl, PHP_EOL;

// https%253A%252F%252Fwww.zyblog.net%253Fopt%253Ddev%2526mail%253Dzyblog%2540net.net%2526comments%253Daaa%2Bbbb%2Bccc%2B%2525dfg%2B%2526%253D%253D%252A%2528%2529%2Bcdg%2526value%253D%25E2%2580%259C%25E4%25B8%25AD%25E6%2596%2587%25E4%25B9%259F%25E6%259C%2589%25E5%2591%2580%25EF%25BC%258C%25E8%25BF%2598%25E6%259C%2589%25E4%25B8%25AD%25E6%2596%2587%25E7%25AC%25A6%25E5%258F%25B7%25EF%25BC%2581%25EF%25BC%2581%25E2%2580%259D

echo rawurldecode($rawenurl), PHP_EOL;

// https%3A%2F%2Fwww.zyblog.net%3Fopt%3Ddev%26mail%3Dzyblog%40net.net%26comments%3Daaa+bbb+ccc+%25dfg+%26%3D%3D%2A%28%29+cdg%26value%3D%E2%80%9C%E4%B8%AD%E6%96%87%E4%B9%9F%E6%9C%89%E5%91%80%EF%BC%8C%E8%BF%98%E6%9C%89%E4%B8%AD%E6%96%87%E7%AC%A6%E5%8F%B7%EF%BC%81%EF%BC%81%E2%80%9D

echo rawurlencode($url), PHP_EOL;

// https%3A%2F%2Fwww.zyblog.net%3Fopt%3Ddev%26mail%3Dzyblog%40net.net%26comments%3Daaa%20bbb%20ccc%20%25dfg%20%26%3D%3D%2A%28%29%20cdg%26value%3D%E2%80%9C%E4%B8%AD%E6%96%87%E4%B9%9F%E6%9C%89%E5%91%80%EF%BC%8C%E8%BF%98%E6%9C%89%E4%B8%AD%E6%96%87%E7%AC%A6%E5%8F%B7%EF%BC%81%EF%BC%81%E2%80%9D

echo rawurldecode($enurl), PHP_EOL;

// https://www.zyblog.net%3Fopt%3 ... 3D%3D*()+cdg&value=“中文也有呀,还有中文符号!!”

接下来我们看到 rawurlencode() 和 rawurldecode()。很多小伙伴都会对它们与普通的urlencode()和urldecode()的区别感到困惑。其实它们的区别主要体现在一些特殊字符上,比如空格。在 urlencode() 中,空格编码为 + 号,在 urlrawencode() 中,空格为 %20。这可以在我们的第三个测试代码中看到。

前两段测试代码对先前编码的 \$enurl 进行操作。第三个测试代码是原创$url的编码。这两个函数是实现 RFC3986 规范的函数。并且 urlencode() 出于历史原因保留了一些特殊情况,例如空格到 + 符号。

最后,我们来看两个非常简单的 Base64 相关的编解码器函数。

$base64url = base64_encode($enurl);

echo $base64url, PHP_EOL;

// aHR0cHMlM0ElMkYlMkZ3d3cuenlibG9nLm5ldCUzRm9wdCUzRGRldiUyNm1haWwlM0R6eWJsb2clNDBuZXQubmV0JTI2Y29tbWVudHMlM0RhYWErYmJiK2NjYyslMjVkZmcrJTI2JTNEJTNEJTJBJTI4JTI5K2NkZyUyNnZhbHVlJTNEJUUyJTgwJTlDJUU0JUI4JUFEJUU2JTk2JTg3JUU0JUI5JTlGJUU2JTlDJTg5JUU1JTkxJTgwJUVGJUJDJThDJUU4JUJGJTk4JUU2JTlDJTg5JUU0JUI4JUFEJUU2JTk2JTg3JUU3JUFDJUE2JUU1JThGJUI3JUVGJUJDJTgxJUVGJUJDJTgxJUUyJTgwJTlE

echo base64_decode($base64url), PHP_EOL;

// https%3A%2F%2Fwww.zyblog.net%3Fopt%3Ddev%26mail%3Dzyblog%40net.net%26comments%3Daaa+bbb+ccc+%25dfg+%26%3D%3D%2A%28%29+cdg%26value%3D%E2%80%9C%E4%B8%AD%E6%96%87%E4%B9%9F%E6%9C%89%E5%91%80%EF%BC%8C%E8%BF%98%E6%9C%89%E4%B8%AD%E6%96%87%E7%AC%A6%E5%8F%B7%EF%BC%81%EF%BC%81%E2%80%9D

其实Base64最大的用处并不体现在对这种普通字符串的编码上,而是体现在编码后传输中二进制字符串的作用。想必用过的同学自然知道。主要针对接口开发,如果我们用Base64对数据进行编码,一是没有加密效果,二是可以增加数据的长度,所以除非有特殊需要,普通传输真的没多少. 有必要对数据进行base64编码。

URL解析操作

除了对URL链接中的字符进行编码和解码之外,解析链接参数也是我们经常使用的一个功能。例如:

$urls = parse_url($url);

var_dump($urls);

// array(3) {

// ["scheme"]=>

// string(5) "https"

// ["host"]=>

// string(14) "www.zyblog.net"

// ["query"]=>

// string(119) "opt=dev&mail=zyblog@net.net&comments=aaa bbb ccc %dfg &==*() cdg&value=“中文也有呀,还有中文符号!!”"

// }

通过 parse_url() 函数,我们可以拆解链接的各个部分。

$parseTestUrl = 'http://username:password%40hos ... 3B%3B

print_r(parse_url($parseTestUrl));

// Array

// (

// [scheme] => http

// [host] => hostname

// [user] => username

// [pass] => password

// [path] => /path

// [query] => arg=value

// [fragment] => anchor

// )

上面的测试环节比较标准。我们还可以看到 parse_url() 可以拆解协议、地址、用户名、密码、路径、查询语句、分片的内容。这些也是形成 URL 链接的标准标准。我们也可以指定我们需要什么。

echo parse_url($parseTestUrl, PHP_URL_PATH); // /path

通过像这样添加第二个参数,我们只能得到我们需要的一部分。当然,对于整个 URL 链接,我们最关心的还是查询部分的内容。我们可以拆卸它们吗?就像 $_GET 获取所有查询数据结果一样。

$querys = [];

parse_str($urls['query'], $querys);

var_dump($querys);

// array(4) {

// ["opt"]=>

// string(3) "dev"

// ["mail"]=>

// string(14) "zyblog@net.net"

// ["comments"]=>

// string(15) "aaa bbb ccc �g "

// ["value"]=>

// string(48) "“中文也有呀,还有中文符号!!”"

// }

parse_str() 这个函数就是解析这种URL链接查询语句的函数。需要注意的是,这个函数的第二个参数是可选的。如果一个变量不用于接收这个函数解析的结果,那么所有的解析结果将直接转换成变量形式。说起来可能有点晕,直接看代码就行了。

parse_str($urls['query']);

echo $value, PHP_EOL; // “中文也有呀,还有中文符号!!”

现在看看。为了防止变量污染的问题,最好有第二个参数,把解析的结果存放在我们指定的地方。最后,让我们看看如何将数组组合成一个 URL 查询。

echo http_build_query($querys), PHP_EOL;

// opt=dev&mail=zyblog%40net.net&comments=aaa+bbb+ccc+%DFg+&value=%E2%80%9C%E4%B8%AD%E6%96%87%E4%B9%9F%E6%9C%89%E5%91%80%EF%BC%8C%E8%BF%98%E6%9C%89%E4%B8%AD%E6%96%87%E7%AC%A6%E5%8F%B7%EF%BC%81%EF%BC%81%E2%80%9D

echo http_build_query($querys, null, '$||#39;, PHP_QUERY_RFC3986), PHP_EOL;

// opt=dev$||$mail=zyblog%40net.net$||$comments=aaa%20bbb%20ccc%20%DFg%20$||$value=%E2%80%9C%E4%B8%AD%E6%96%87%E4%B9%9F%E6%9C%89%E5%91%80%EF%BC%8C%E8%BF%98%E6%9C%89%E4%B8%AD%E6%96%87%E7%AC%A6%E5%8F%B7%EF%BC%81%EF%BC%81%E2%80%9D

http_build_query() 其实做过外部接口开发的同学都不会陌生。因为太方便了。不过需要注意的是,这个函数会自动使用 rawurlencode() 对数据进行编码。此外,它还有几个可选参数。比如我们修改了第二个测试代码中的连接符号,将原来的&符号替换为我们自定义的符号来拼接URL查询语句。

解析文件或远程地址的响应头和元信息

对于远程文件请求,响应头信息也很重要。其实在URL相关的组件中也有直接获取响应头的功能。

$url = 'https://www.sina.com.cn';

print_r(get_headers($url));

// Array

// (

// [0] => HTTP/1.1 200 OK

// [1] => Server: nginx

// [2] => Date: Mon, 25 Jan 2021 02:08:35 GMT

// [3] => Content-Type: text/html

// [4] => Content-Length: 530418

// [5] => Connection: close

// [6] => Vary: Accept-Encoding

// [7] => ETag: "600e278a-7c65e"V=5965C31

// [8] => X-Powered-By: shci_v1.13

// [9] => Expires: Mon, 25 Jan 2021 02:09:12 GMT

// [10] => Cache-Control: max-age=60

// [11] => X-Via-SSL: ssl.22.sinag1.qxg.lb.sinanode.com

// [12] => Edge-Copy-Time: 1611540513080

// [13] => Age: 24

// [14] => Via: https/1.1 cmcc.guangzhou.union.82 (ApacheTrafficServer/6.2.1 [cRs f ]), https/1.1 cmcc.jiangxi.union.175 (ApacheTrafficServer/6.2.1 [cRs f ])

// [15] => X-Via-Edge: 1611540515462770a166fee55a97524d289c7

// [16] => X-Cache: HIT.175

// [17] => X-Via-CDN: f=edge,s=cmcc.jiangxi.union.166.nb.sinaedge.com,c=111.22.10.119;f=edge,s=cmcc.jiangxi.union.168.nb.sinaedge.com,c=117.169.85.166;f=Edge,s=cmcc.jiangxi.union.175,c=117.169.85.168

// )

print_r(get_headers($url, 1));

// Array

// (

// [0] => HTTP/1.1 200 OK

// [Server] => nginx

// [Date] => Mon, 25 Jan 2021 02:08:35 GMT

// [Content-Type] => text/html

// [Content-Length] => 530418

// [Connection] => close

// [Vary] => Accept-Encoding

// [ETag] => "600e278a-7c65e"V=5965C31

// [X-Powered-By] => shci_v1.13

// [Expires] => Mon, 25 Jan 2021 02:09:12 GMT

// [Cache-Control] => max-age=60

// [X-Via-SSL] => ssl.22.sinag1.qxg.lb.sinanode.com

// [Edge-Copy-Time] => 1611540513080

// [Age] => 24

// [Via] => https/1.1 cmcc.guangzhou.union.82 (ApacheTrafficServer/6.2.1 [cRs f ]), https/1.1 cmcc.jiangxi.union.175 (ApacheTrafficServer/6.2.1 [cRs f ])

// [X-Via-Edge] => 1611540515593770a166fee55a97568f1a9d6

// [X-Cache] => HIT.175

// [X-Via-CDN] => f=edge,s=cmcc.jiangxi.union.165.nb.sinaedge.com,c=111.22.10.119;f=edge,s=cmcc.jiangxi.union.175.nb.sinaedge.com,c=117.169.85.165;f=Edge,s=cmcc.jiangxi.union.175,c=117.169.85.175

// )

目标地址服务器返回的响应头信息可以直接通过get_headers()函数获取。它的第二个参数可以以键值下标的形式返回数据。除了响应头,我们还可以获得网站的所有meta标签的内容。

var_dump(get_meta_tags($url));

// array(11) {

// ["keywords"]=>

// string(65) "新浪,新浪网,SINA,sina,sina.com.cn,新浪首页,门户,资讯"

// ["description"]=>

// string(331) "新浪网为全球用户24小时提供全面及时的中文资讯,内容覆盖国内外突发新闻事件、体坛赛事、娱乐时尚、产业资讯、实用信息等,设有新闻、体育、娱乐、财经、科技、房产、汽车等30多个内容频道,同时开设博客、视频、论坛等自由互动交流空间。"

// ["referrer"]=>

// string(6) "always"

// ["stencil"]=>

// string(10) "PGLS000022"

// ["publishid"]=>

// string(8) "30,131,1"

// ["verify-v1"]=>

// string(44) "6HtwmypggdgP1NLw7NOuQBI2TW8+CfkYCoyeB8IDbn8="

// ["application-name"]=>

// string(12) "新浪首页"

// ["msapplication-tileimage"]=>

// string(42) "//i1.sinaimg.cn/dy/deco/2013/0312/logo.png"

// ["msapplication-tilecolor"]=>

// string(7) "#ffbf27"

// ["baidu_ssp_verify"]=>

// string(32) "c0e9f36397049594fb9ac93a6316c65b"

// ["sudameta"]=>

// string(20) "dataid:wpcomos:96318"

// }

该功能不仅对远程链接网站有用,还可以直接查看本地静态文件中所有meta标签的内容,我们只需要将参数的远程链接替换为本地文件的路径即可. ,你可以自己试试。

总结

今天的内容比较简单,主要是日常工作中经常用到的这些功能。不过有些参数的用法可能很多朋友都不清楚,比如parse_str()函数的第二个参数的问题。所以就像我一开始说的,这个文章是一个回顾和巩固,也起到加深理解的作用。经过深入研究,结合实际应用,会更容易掌握。

测试代码:

学习PHP.php中URL相关的操作函数

参考文档: 查看全部

php抓取网页匹配url(区分和搞清楚每个函数真正的用处-乐题库)

在日常业务开发过程中,我们经常会有处理URL链接的需求,所以今天学习的功能其实是大家经常用到的一些功能。在之前的工作过程中,其实我对这些功能只是一个模糊的概念,我知道,但是当我真的需要使用它的时候,我还是需要阅读文档来确定我真正要使用哪个功能。因此,今天我们将其作为一个复习练习,主要是为了区分和弄清楚每个功能的真实用途。

编码运算函数

首先要看的是与 URL 编码相关的函数。有些浏览器会在我们复制粘贴后自动对 URL 进行 URL 编码,也就是很多百分号的形式。在 PHP 中,也有相应的编解码器函数。

$url = "zyblog@net.net&comments=aaa" rel="nofollow" target="_blank">https://www.zyblog.net%3Fopt%3 ... 3Daaa bbb ccc %dfg &==*() cdg&value=“中文也有呀,还有中文符号!!”";

echo $url, PHP_EOL;

// zyblog@net.net&comments=aaa" rel="nofollow" target="_blank">https://www.zyblog.net%3Fopt%3 ... 3Daaa bbb ccc %dfg &==*() cdg&value=“中文也有呀,还有中文符号!!”

$enurl = urlencode($url);

echo $enurl, PHP_EOL;

// https%3A%2F%2Fwww.zyblog.net%3Fopt%3Ddev%26mail%3Dzyblog%40net.net%26comments%3Daaa+bbb+ccc+%25dfg+%26%3D%3D%2A%28%29+cdg%26value%3D%E2%80%9C%E4%B8%AD%E6%96%87%E4%B9%9F%E6%9C%89%E5%91%80%EF%BC%8C%E8%BF%98%E6%9C%89%E4%B8%AD%E6%96%87%E7%AC%A6%E5%8F%B7%EF%BC%81%EF%BC%81%E2%80%9D

echo urldecode($enurl), PHP_EOL;

// zyblog@net.net&comments=aaa" rel="nofollow" target="_blank">https://www.zyblog.net%3Fopt%3 ... 3Daaa bbb ccc %dfg &==*() cdg&value=“中文也有呀,还有中文符号!!”

这两个函数估计是最常用的函数。urlencode() 是 URL 的编码操作。如您所见,我们准备的链接已被编码为收录各种百分号的内容。尤其是汉字,如果链接中的中文参数是GET方法,编码后的内容会使链接很长。urldecode() 是对应解码函数的函数,可以将编码后的链接解码回原来的状态。

$rawenurl = rawurlencode($enurl);

echo $rawenurl, PHP_EOL;

// https%253A%252F%252Fwww.zyblog.net%253Fopt%253Ddev%2526mail%253Dzyblog%2540net.net%2526comments%253Daaa%2Bbbb%2Bccc%2B%2525dfg%2B%2526%253D%253D%252A%2528%2529%2Bcdg%2526value%253D%25E2%2580%259C%25E4%25B8%25AD%25E6%2596%2587%25E4%25B9%259F%25E6%259C%2589%25E5%2591%2580%25EF%25BC%258C%25E8%25BF%2598%25E6%259C%2589%25E4%25B8%25AD%25E6%2596%2587%25E7%25AC%25A6%25E5%258F%25B7%25EF%25BC%2581%25EF%25BC%2581%25E2%2580%259D

echo rawurldecode($rawenurl), PHP_EOL;

// https%3A%2F%2Fwww.zyblog.net%3Fopt%3Ddev%26mail%3Dzyblog%40net.net%26comments%3Daaa+bbb+ccc+%25dfg+%26%3D%3D%2A%28%29+cdg%26value%3D%E2%80%9C%E4%B8%AD%E6%96%87%E4%B9%9F%E6%9C%89%E5%91%80%EF%BC%8C%E8%BF%98%E6%9C%89%E4%B8%AD%E6%96%87%E7%AC%A6%E5%8F%B7%EF%BC%81%EF%BC%81%E2%80%9D

echo rawurlencode($url), PHP_EOL;

// https%3A%2F%2Fwww.zyblog.net%3Fopt%3Ddev%26mail%3Dzyblog%40net.net%26comments%3Daaa%20bbb%20ccc%20%25dfg%20%26%3D%3D%2A%28%29%20cdg%26value%3D%E2%80%9C%E4%B8%AD%E6%96%87%E4%B9%9F%E6%9C%89%E5%91%80%EF%BC%8C%E8%BF%98%E6%9C%89%E4%B8%AD%E6%96%87%E7%AC%A6%E5%8F%B7%EF%BC%81%EF%BC%81%E2%80%9D

echo rawurldecode($enurl), PHP_EOL;

// zyblog@net.net&comments=aaa+bbb+ccc+%dfg+&==" rel="nofollow" target="_blank">https://www.zyblog.net%3Fopt%3 ... 3D%3D*()+cdg&value=“中文也有呀,还有中文符号!!”

接下来我们看到 rawurlencode() 和 rawurldecode()。很多小伙伴都会对它们与普通的urlencode()和urldecode()的区别感到困惑。其实它们的区别主要体现在一些特殊字符上,比如空格。在 urlencode() 中,空格编码为 + 号,在 urlrawencode() 中,空格为 %20。这可以在我们的第三个测试代码中看到。

前两段测试代码对先前编码的 \$enurl 进行操作。第三个测试代码是原创$url的编码。这两个函数是实现 RFC3986 规范的函数。并且 urlencode() 出于历史原因保留了一些特殊情况,例如空格到 + 符号。

最后,我们来看两个非常简单的 Base64 相关的编解码器函数。

$base64url = base64_encode($enurl);

echo $base64url, PHP_EOL;

// aHR0cHMlM0ElMkYlMkZ3d3cuenlibG9nLm5ldCUzRm9wdCUzRGRldiUyNm1haWwlM0R6eWJsb2clNDBuZXQubmV0JTI2Y29tbWVudHMlM0RhYWErYmJiK2NjYyslMjVkZmcrJTI2JTNEJTNEJTJBJTI4JTI5K2NkZyUyNnZhbHVlJTNEJUUyJTgwJTlDJUU0JUI4JUFEJUU2JTk2JTg3JUU0JUI5JTlGJUU2JTlDJTg5JUU1JTkxJTgwJUVGJUJDJThDJUU4JUJGJTk4JUU2JTlDJTg5JUU0JUI4JUFEJUU2JTk2JTg3JUU3JUFDJUE2JUU1JThGJUI3JUVGJUJDJTgxJUVGJUJDJTgxJUUyJTgwJTlE

echo base64_decode($base64url), PHP_EOL;

// https%3A%2F%2Fwww.zyblog.net%3Fopt%3Ddev%26mail%3Dzyblog%40net.net%26comments%3Daaa+bbb+ccc+%25dfg+%26%3D%3D%2A%28%29+cdg%26value%3D%E2%80%9C%E4%B8%AD%E6%96%87%E4%B9%9F%E6%9C%89%E5%91%80%EF%BC%8C%E8%BF%98%E6%9C%89%E4%B8%AD%E6%96%87%E7%AC%A6%E5%8F%B7%EF%BC%81%EF%BC%81%E2%80%9D

其实Base64最大的用处并不体现在对这种普通字符串的编码上,而是体现在编码后传输中二进制字符串的作用。想必用过的同学自然知道。主要针对接口开发,如果我们用Base64对数据进行编码,一是没有加密效果,二是可以增加数据的长度,所以除非有特殊需要,普通传输真的没多少. 有必要对数据进行base64编码。

URL解析操作

除了对URL链接中的字符进行编码和解码之外,解析链接参数也是我们经常使用的一个功能。例如:

$urls = parse_url($url);

var_dump($urls);

// array(3) {

// ["scheme"]=>

// string(5) "https"

// ["host"]=>

// string(14) "www.zyblog.net"

// ["query"]=>

// string(119) "opt=dev&mail=zyblog@net.net&comments=aaa bbb ccc %dfg &==*() cdg&value=“中文也有呀,还有中文符号!!”"

// }

通过 parse_url() 函数,我们可以拆解链接的各个部分。

$parseTestUrl = 'http://username:password%40hos ... 3B%3B

print_r(parse_url($parseTestUrl));

// Array

// (

// [scheme] => http

// [host] => hostname

// [user] => username

// [pass] => password

// [path] => /path

// [query] => arg=value

// [fragment] => anchor

// )

上面的测试环节比较标准。我们还可以看到 parse_url() 可以拆解协议、地址、用户名、密码、路径、查询语句、分片的内容。这些也是形成 URL 链接的标准标准。我们也可以指定我们需要什么。

echo parse_url($parseTestUrl, PHP_URL_PATH); // /path

通过像这样添加第二个参数,我们只能得到我们需要的一部分。当然,对于整个 URL 链接,我们最关心的还是查询部分的内容。我们可以拆卸它们吗?就像 $_GET 获取所有查询数据结果一样。

$querys = [];

parse_str($urls['query'], $querys);

var_dump($querys);

// array(4) {

// ["opt"]=>

// string(3) "dev"

// ["mail"]=>

// string(14) "zyblog@net.net"

// ["comments"]=>

// string(15) "aaa bbb ccc �g "

// ["value"]=>

// string(48) "“中文也有呀,还有中文符号!!”"

// }

parse_str() 这个函数就是解析这种URL链接查询语句的函数。需要注意的是,这个函数的第二个参数是可选的。如果一个变量不用于接收这个函数解析的结果,那么所有的解析结果将直接转换成变量形式。说起来可能有点晕,直接看代码就行了。

parse_str($urls['query']);

echo $value, PHP_EOL; // “中文也有呀,还有中文符号!!”

现在看看。为了防止变量污染的问题,最好有第二个参数,把解析的结果存放在我们指定的地方。最后,让我们看看如何将数组组合成一个 URL 查询。

echo http_build_query($querys), PHP_EOL;

// opt=dev&mail=zyblog%40net.net&comments=aaa+bbb+ccc+%DFg+&value=%E2%80%9C%E4%B8%AD%E6%96%87%E4%B9%9F%E6%9C%89%E5%91%80%EF%BC%8C%E8%BF%98%E6%9C%89%E4%B8%AD%E6%96%87%E7%AC%A6%E5%8F%B7%EF%BC%81%EF%BC%81%E2%80%9D

echo http_build_query($querys, null, '$||#39;, PHP_QUERY_RFC3986), PHP_EOL;

// opt=dev$||$mail=zyblog%40net.net$||$comments=aaa%20bbb%20ccc%20%DFg%20$||$value=%E2%80%9C%E4%B8%AD%E6%96%87%E4%B9%9F%E6%9C%89%E5%91%80%EF%BC%8C%E8%BF%98%E6%9C%89%E4%B8%AD%E6%96%87%E7%AC%A6%E5%8F%B7%EF%BC%81%EF%BC%81%E2%80%9D

http_build_query() 其实做过外部接口开发的同学都不会陌生。因为太方便了。不过需要注意的是,这个函数会自动使用 rawurlencode() 对数据进行编码。此外,它还有几个可选参数。比如我们修改了第二个测试代码中的连接符号,将原来的&符号替换为我们自定义的符号来拼接URL查询语句。

解析文件或远程地址的响应头和元信息

对于远程文件请求,响应头信息也很重要。其实在URL相关的组件中也有直接获取响应头的功能。

$url = 'https://www.sina.com.cn';

print_r(get_headers($url));

// Array

// (

// [0] => HTTP/1.1 200 OK

// [1] => Server: nginx

// [2] => Date: Mon, 25 Jan 2021 02:08:35 GMT

// [3] => Content-Type: text/html

// [4] => Content-Length: 530418

// [5] => Connection: close

// [6] => Vary: Accept-Encoding

// [7] => ETag: "600e278a-7c65e"V=5965C31

// [8] => X-Powered-By: shci_v1.13

// [9] => Expires: Mon, 25 Jan 2021 02:09:12 GMT

// [10] => Cache-Control: max-age=60

// [11] => X-Via-SSL: ssl.22.sinag1.qxg.lb.sinanode.com

// [12] => Edge-Copy-Time: 1611540513080

// [13] => Age: 24

// [14] => Via: https/1.1 cmcc.guangzhou.union.82 (ApacheTrafficServer/6.2.1 [cRs f ]), https/1.1 cmcc.jiangxi.union.175 (ApacheTrafficServer/6.2.1 [cRs f ])

// [15] => X-Via-Edge: 1611540515462770a166fee55a97524d289c7

// [16] => X-Cache: HIT.175

// [17] => X-Via-CDN: f=edge,s=cmcc.jiangxi.union.166.nb.sinaedge.com,c=111.22.10.119;f=edge,s=cmcc.jiangxi.union.168.nb.sinaedge.com,c=117.169.85.166;f=Edge,s=cmcc.jiangxi.union.175,c=117.169.85.168

// )

print_r(get_headers($url, 1));

// Array

// (

// [0] => HTTP/1.1 200 OK

// [Server] => nginx

// [Date] => Mon, 25 Jan 2021 02:08:35 GMT

// [Content-Type] => text/html

// [Content-Length] => 530418

// [Connection] => close

// [Vary] => Accept-Encoding

// [ETag] => "600e278a-7c65e"V=5965C31

// [X-Powered-By] => shci_v1.13

// [Expires] => Mon, 25 Jan 2021 02:09:12 GMT

// [Cache-Control] => max-age=60

// [X-Via-SSL] => ssl.22.sinag1.qxg.lb.sinanode.com

// [Edge-Copy-Time] => 1611540513080

// [Age] => 24

// [Via] => https/1.1 cmcc.guangzhou.union.82 (ApacheTrafficServer/6.2.1 [cRs f ]), https/1.1 cmcc.jiangxi.union.175 (ApacheTrafficServer/6.2.1 [cRs f ])

// [X-Via-Edge] => 1611540515593770a166fee55a97568f1a9d6

// [X-Cache] => HIT.175

// [X-Via-CDN] => f=edge,s=cmcc.jiangxi.union.165.nb.sinaedge.com,c=111.22.10.119;f=edge,s=cmcc.jiangxi.union.175.nb.sinaedge.com,c=117.169.85.165;f=Edge,s=cmcc.jiangxi.union.175,c=117.169.85.175

// )

目标地址服务器返回的响应头信息可以直接通过get_headers()函数获取。它的第二个参数可以以键值下标的形式返回数据。除了响应头,我们还可以获得网站的所有meta标签的内容。

var_dump(get_meta_tags($url));

// array(11) {

// ["keywords"]=>

// string(65) "新浪,新浪网,SINA,sina,sina.com.cn,新浪首页,门户,资讯"

// ["description"]=>

// string(331) "新浪网为全球用户24小时提供全面及时的中文资讯,内容覆盖国内外突发新闻事件、体坛赛事、娱乐时尚、产业资讯、实用信息等,设有新闻、体育、娱乐、财经、科技、房产、汽车等30多个内容频道,同时开设博客、视频、论坛等自由互动交流空间。"

// ["referrer"]=>

// string(6) "always"

// ["stencil"]=>

// string(10) "PGLS000022"

// ["publishid"]=>

// string(8) "30,131,1"

// ["verify-v1"]=>

// string(44) "6HtwmypggdgP1NLw7NOuQBI2TW8+CfkYCoyeB8IDbn8="

// ["application-name"]=>

// string(12) "新浪首页"

// ["msapplication-tileimage"]=>

// string(42) "//i1.sinaimg.cn/dy/deco/2013/0312/logo.png"

// ["msapplication-tilecolor"]=>

// string(7) "#ffbf27"

// ["baidu_ssp_verify"]=>

// string(32) "c0e9f36397049594fb9ac93a6316c65b"

// ["sudameta"]=>

// string(20) "dataid:wpcomos:96318"

// }

该功能不仅对远程链接网站有用,还可以直接查看本地静态文件中所有meta标签的内容,我们只需要将参数的远程链接替换为本地文件的路径即可. ,你可以自己试试。

总结

今天的内容比较简单,主要是日常工作中经常用到的这些功能。不过有些参数的用法可能很多朋友都不清楚,比如parse_str()函数的第二个参数的问题。所以就像我一开始说的,这个文章是一个回顾和巩固,也起到加深理解的作用。经过深入研究,结合实际应用,会更容易掌握。

测试代码:

学习PHP.php中URL相关的操作函数

参考文档:

php抓取网页匹配url(Googlewebmaster内置多语言功能判断URL参数、Cookies、HTTP_ACCEPT)

网站优化 • 优采云 发表了文章 • 0 个评论 • 76 次浏览 • 2022-02-07 21:03

前言

ThinkPHP内置多语言功能,但通过判断URL参数、Cookies、HTTP_ACCEPT_LANGUAGE请求参数返回语言包。由于多种语言的url是固定的,所以搜索引擎爬取页面时,页面返回的语言取决于爬虫携带的请求头,对SEO有一定的影响,很难全面收录@ >各种语言的版本。例如,谷歌站长支持的文章“管理多个区域和语言网站”提到:

Google 建议不要使用 cookie 或浏览器设置来调整页面内容的语言,而是为页面的每个语言版本使用不同的 URL。

如果您想根据语言设置动态更改内容或重新路由用户,请注意 Google 可能无法找到并抓取您的所有变体。这是因为 Googlebot 抓取工具通常来自美国。另外,爬虫在发送 HTTP 请求时没有在请求头中设置 Accept-Language。

完成

示例项目可以在 文章 的底部下载。

进入tp6项目目录,首先在config\lang.php中设置默认语言和允许的语言列表。我已设置为允许简体中文、繁体中文和英文。

在config\route.php中设置路由配置,开启强制路由url_route_must并完全匹配route_complete_match,避免设置可能引起的冲突问题。

进入app目录,新建lang目录,编写语言包。

<p>1//zh_cn.php

2 查看全部

php抓取网页匹配url(Googlewebmaster内置多语言功能判断URL参数、Cookies、HTTP_ACCEPT)

前言

ThinkPHP内置多语言功能,但通过判断URL参数、Cookies、HTTP_ACCEPT_LANGUAGE请求参数返回语言包。由于多种语言的url是固定的,所以搜索引擎爬取页面时,页面返回的语言取决于爬虫携带的请求头,对SEO有一定的影响,很难全面收录@ >各种语言的版本。例如,谷歌站长支持的文章“管理多个区域和语言网站”提到:

Google 建议不要使用 cookie 或浏览器设置来调整页面内容的语言,而是为页面的每个语言版本使用不同的 URL。

如果您想根据语言设置动态更改内容或重新路由用户,请注意 Google 可能无法找到并抓取您的所有变体。这是因为 Googlebot 抓取工具通常来自美国。另外,爬虫在发送 HTTP 请求时没有在请求头中设置 Accept-Language。

完成

示例项目可以在 文章 的底部下载。

进入tp6项目目录,首先在config\lang.php中设置默认语言和允许的语言列表。我已设置为允许简体中文、繁体中文和英文。

在config\route.php中设置路由配置,开启强制路由url_route_must并完全匹配route_complete_match,避免设置可能引起的冲突问题。

进入app目录,新建lang目录,编写语言包。

<p>1//zh_cn.php

2

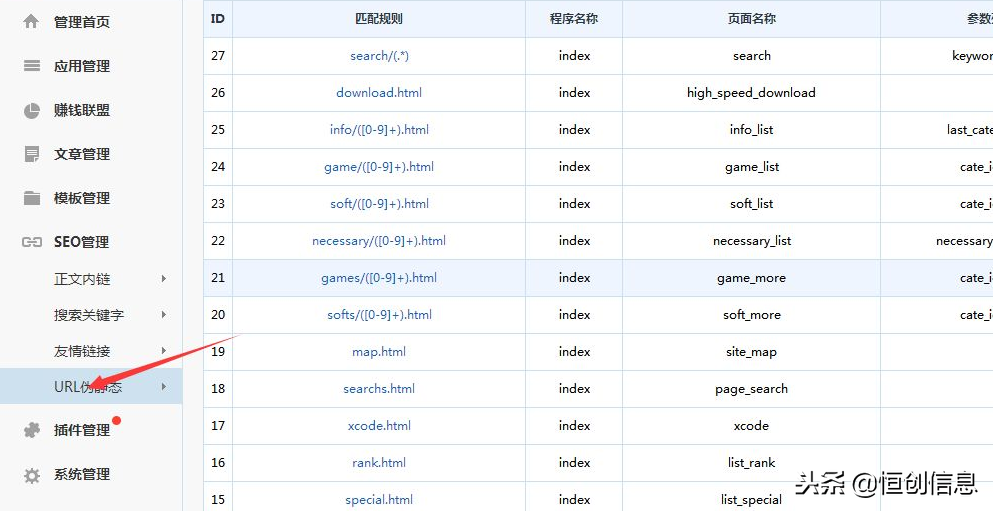

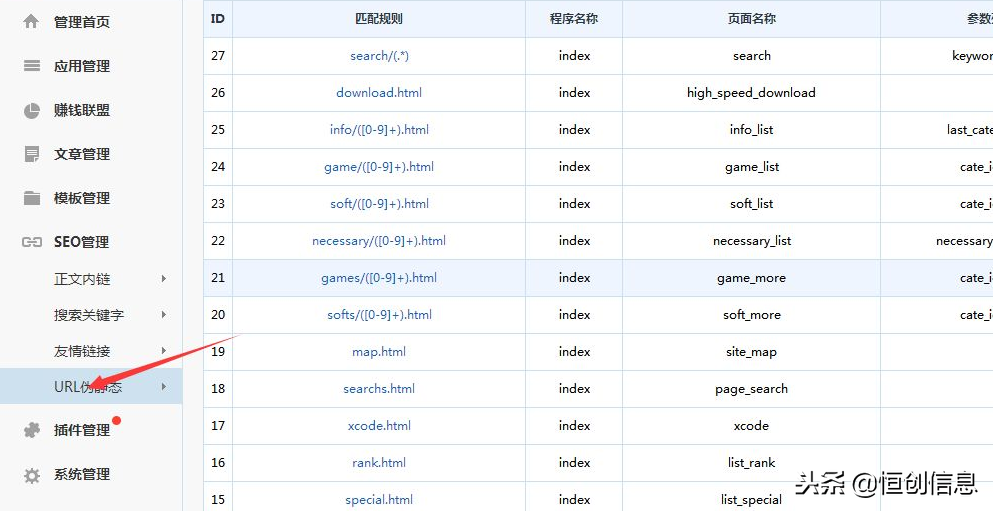

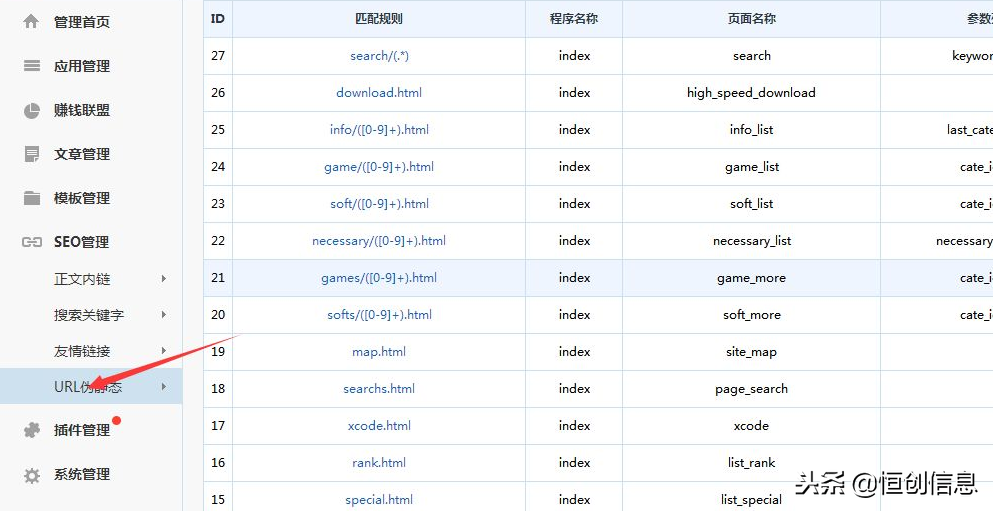

php抓取网页匹配url(先说一下网站结构中的URL优化注意事项伪静态分析)

网站优化 • 优采云 发表了文章 • 0 个评论 • 82 次浏览 • 2022-02-06 13:21

现场SEO优化是核心部分。有时,一个好的站内结构甚至不需要发送外部链接就可以吸引搜索引擎的青睐。百度之前也有解释过,百度的算法取消了外链传递权重的作用。当然,取消权重的传递并不意味着外链完全没用。关于文章外链,后面会分享给大家。今天就来说说网站结构中的URL优化注意事项。

一个好的网站结构不仅可以引导蜘蛛的爬行,还需要起到合理的重量传递作用。另外,一个好的网站权重也是提升用户体验的必要步骤。

URL注意事项,URL优化主要包括以下三点:1、目录级别,2、伪静态,3、关键词,4、中文路径,< @5、相对路径和绝对路径,6、字母大小写问题,7、目录最后一个斜杠。我们逐项分析。

第一点是目录级别的问题。目录级别不宜过多。大部分新手站长使用cms来搭建网站后台,很多cms后台路径已经配置好了。例如,根目录/列/年/月、日期/文章号等目录级别有5个以上。这样的URL目录结构不利于爬取已经传递的权重。下面我们来学习如何修改cms系统的目录结构,将目录结构改为首页/栏目页/详情页的结构。

第二点是伪静态的。建议对 网站 URL 使用静态或伪静态 URL。所谓的动态目录通常有?比如特殊符号或者带参数的 URL 链接,那为什么推荐使用伪静态 URL?在搜索引擎的初始阶段,它无法识别动态参数,因此可能会导致一些爬取错误或生成无效的网址,从而降低体验。随着搜索引擎的发展,现在已经可以识别动态参数,这意味着简单的带参数的 URL 不需要是伪静态的。在做优化分析的时候,也建议站长不要看到动态链接。伪静态。除非您想将 关键词 添加到伪静态 URL 或想让您的优化看起来更专业。

第三点关键词,最好在URL中收录关键词,如ipad3、web、seo等。在URL中加上这些字或拼音。网页为收录后,百度也会根据URL中的关键词匹配搜索结果。

第四点是中文网址。不建议使用中文网址。搜索引擎可以识别带有中文字符的 URL,但是 URL 通常是通过编码来表示的,所以我这里不推荐使用中文 URL。

第五点是相对路径和绝对路径。根据我的经验,推荐大家使用绝对路径,这样可以让搜索引擎更快的抓取网站内容,让一些懒惰的采集用户自动给我们加链。绝对路径的缺点是开发时不方便测试,而且会增加网页的大小。网站先不说开发测试,通过简化代码可以缩小页面大小,大部分搜索引擎都可以完全爬取页面内容。

第六点是字母的大小写。你不需要说太多。只要记住统一使用小写字母,不要添加特殊符号。

第七点末尾的斜线,建议统一URL规范网站。URL末尾会有/abc和/abc/两种情况。对于搜索引擎来说,这是两个链接,会造成重复页面的问题。所以我们需要对整个站点有一个统一的标准。这里建议大家带上最后的斜线或者加.html来统一网站URL。

现场SEO优化是核心部分。有时,一个好的站内结构甚至不需要发送外部链接就可以吸引搜索引擎的青睐。百度之前也有解释过,百度的算法取消了外链传递权重的作用。当然,取消权重的传递并不意味着外链完全没用。关于文章外链,后面会分享给大家。今天就来说说网站结构中的URL优化注意事项。

一个好的网站结构不仅可以引导蜘蛛的爬行,还需要起到合理的重量传递作用。另外,一个好的网站权重也是提升用户体验的必要步骤。

URL注意事项,URL优化主要包括以下三点:1、目录级别,2、伪静态,3、关键词,4、中文路径,< @5、相对路径和绝对路径,6、字母大小写问题,7、目录最后一个斜杠。我们逐项分析。

第一点是目录级别的问题。目录级别不宜过多。大部分新手站长使用cms来搭建网站后台,很多cms后台路径已经配置好了。例如,根目录/列/年/月、日期/文章号等目录级别有5个以上。这样的URL目录结构不利于爬取已经传递的权重。下面我们来学习如何修改cms系统的目录结构,将目录结构改为首页/栏目页/详情页的结构。

第二点是伪静态的。建议对 网站 URL 使用静态或伪静态 URL。所谓的动态目录通常有?比如特殊符号或者带参数的 URL 链接,那为什么推荐使用伪静态 URL?在搜索引擎的初始阶段,它无法识别动态参数,因此可能会导致一些爬取错误或生成无效的网址,从而降低体验。随着搜索引擎的发展,现在已经可以识别动态参数,这意味着简单的带参数的 URL 不需要是伪静态的。在做优化分析的时候,也建议站长不要看到动态链接。伪静态。除非您想将 关键词 添加到伪静态 URL 或想让您的优化看起来更专业。

第三点关键词,最好在URL中收录关键词,如ipad3、web、seo等。在URL中加上这些字或拼音。网页为收录后,百度也会根据URL中的关键词匹配搜索结果。

第四点是中文网址。不建议使用中文网址。搜索引擎可以识别带有中文字符的 URL,但是 URL 通常是通过编码来表示的,所以我这里不推荐使用中文 URL。

第五点是相对路径和绝对路径。根据我的经验,推荐大家使用绝对路径,这样可以让搜索引擎更快的抓取网站内容,让一些懒惰的采集用户自动给我们加链。绝对路径的缺点是开发时不方便测试,而且会增加网页的大小。网站先不说开发测试,通过简化代码可以缩小页面大小,大部分搜索引擎都可以完全爬取页面内容。

第六点是字母的大小写。你不需要说太多。只要记住统一使用小写字母,不要添加特殊符号。

第七点末尾的斜线,建议统一URL规范网站。URL末尾会有/abc和/abc/两种情况。对于搜索引擎来说,这是两个链接,会造成重复页面的问题。所以我们需要对整个站点有一个统一的标准。这里建议大家带上最后的斜线或者加.html来统一网站URL。 查看全部

php抓取网页匹配url(先说一下网站结构中的URL优化注意事项伪静态分析)

现场SEO优化是核心部分。有时,一个好的站内结构甚至不需要发送外部链接就可以吸引搜索引擎的青睐。百度之前也有解释过,百度的算法取消了外链传递权重的作用。当然,取消权重的传递并不意味着外链完全没用。关于文章外链,后面会分享给大家。今天就来说说网站结构中的URL优化注意事项。

一个好的网站结构不仅可以引导蜘蛛的爬行,还需要起到合理的重量传递作用。另外,一个好的网站权重也是提升用户体验的必要步骤。

URL注意事项,URL优化主要包括以下三点:1、目录级别,2、伪静态,3、关键词,4、中文路径,< @5、相对路径和绝对路径,6、字母大小写问题,7、目录最后一个斜杠。我们逐项分析。

第一点是目录级别的问题。目录级别不宜过多。大部分新手站长使用cms来搭建网站后台,很多cms后台路径已经配置好了。例如,根目录/列/年/月、日期/文章号等目录级别有5个以上。这样的URL目录结构不利于爬取已经传递的权重。下面我们来学习如何修改cms系统的目录结构,将目录结构改为首页/栏目页/详情页的结构。

第二点是伪静态的。建议对 网站 URL 使用静态或伪静态 URL。所谓的动态目录通常有?比如特殊符号或者带参数的 URL 链接,那为什么推荐使用伪静态 URL?在搜索引擎的初始阶段,它无法识别动态参数,因此可能会导致一些爬取错误或生成无效的网址,从而降低体验。随着搜索引擎的发展,现在已经可以识别动态参数,这意味着简单的带参数的 URL 不需要是伪静态的。在做优化分析的时候,也建议站长不要看到动态链接。伪静态。除非您想将 关键词 添加到伪静态 URL 或想让您的优化看起来更专业。

第三点关键词,最好在URL中收录关键词,如ipad3、web、seo等。在URL中加上这些字或拼音。网页为收录后,百度也会根据URL中的关键词匹配搜索结果。

第四点是中文网址。不建议使用中文网址。搜索引擎可以识别带有中文字符的 URL,但是 URL 通常是通过编码来表示的,所以我这里不推荐使用中文 URL。

第五点是相对路径和绝对路径。根据我的经验,推荐大家使用绝对路径,这样可以让搜索引擎更快的抓取网站内容,让一些懒惰的采集用户自动给我们加链。绝对路径的缺点是开发时不方便测试,而且会增加网页的大小。网站先不说开发测试,通过简化代码可以缩小页面大小,大部分搜索引擎都可以完全爬取页面内容。

第六点是字母的大小写。你不需要说太多。只要记住统一使用小写字母,不要添加特殊符号。

第七点末尾的斜线,建议统一URL规范网站。URL末尾会有/abc和/abc/两种情况。对于搜索引擎来说,这是两个链接,会造成重复页面的问题。所以我们需要对整个站点有一个统一的标准。这里建议大家带上最后的斜线或者加.html来统一网站URL。

现场SEO优化是核心部分。有时,一个好的站内结构甚至不需要发送外部链接就可以吸引搜索引擎的青睐。百度之前也有解释过,百度的算法取消了外链传递权重的作用。当然,取消权重的传递并不意味着外链完全没用。关于文章外链,后面会分享给大家。今天就来说说网站结构中的URL优化注意事项。

一个好的网站结构不仅可以引导蜘蛛的爬行,还需要起到合理的重量传递作用。另外,一个好的网站权重也是提升用户体验的必要步骤。

URL注意事项,URL优化主要包括以下三点:1、目录级别,2、伪静态,3、关键词,4、中文路径,< @5、相对路径和绝对路径,6、字母大小写问题,7、目录最后一个斜杠。我们逐项分析。

第一点是目录级别的问题。目录级别不宜过多。大部分新手站长使用cms来搭建网站后台,很多cms后台路径已经配置好了。例如,根目录/列/年/月、日期/文章号等目录级别有5个以上。这样的URL目录结构不利于爬取已经传递的权重。下面我们来学习如何修改cms系统的目录结构,将目录结构改为首页/栏目页/详情页的结构。

第二点是伪静态的。建议对 网站 URL 使用静态或伪静态 URL。所谓的动态目录通常有?比如特殊符号或者带参数的 URL 链接,那为什么推荐使用伪静态 URL?在搜索引擎的初始阶段,它无法识别动态参数,因此可能会导致一些爬取错误或生成无效的网址,从而降低体验。随着搜索引擎的发展,现在已经可以识别动态参数,这意味着简单的带参数的 URL 不需要是伪静态的。在做优化分析的时候,也建议站长不要看到动态链接。伪静态。除非您想将 关键词 添加到伪静态 URL 或想让您的优化看起来更专业。

第三点关键词,最好在URL中收录关键词,如ipad3、web、seo等。在URL中加上这些字或拼音。网页为收录后,百度也会根据URL中的关键词匹配搜索结果。

第四点是中文网址。不建议使用中文网址。搜索引擎可以识别带有中文字符的 URL,但是 URL 通常是通过编码来表示的,所以我这里不推荐使用中文 URL。

第五点是相对路径和绝对路径。根据我的经验,推荐大家使用绝对路径,这样可以让搜索引擎更快的抓取网站内容,让一些懒惰的采集用户自动给我们加链。绝对路径的缺点是开发时不方便测试,而且会增加网页的大小。网站先不说开发测试,通过简化代码可以缩小页面大小,大部分搜索引擎都可以完全爬取页面内容。

第六点是字母的大小写。你不需要说太多。只要记住统一使用小写字母,不要添加特殊符号。

第七点末尾的斜线,建议统一URL规范网站。URL末尾会有/abc和/abc/两种情况。对于搜索引擎来说,这是两个链接,会造成重复页面的问题。所以我们需要对整个站点有一个统一的标准。这里建议大家带上最后的斜线或者加.html来统一网站URL。

php抓取网页匹配url(php抓取网页匹配url里的特定字符串,比如,然后生成sqlite)

网站优化 • 优采云 发表了文章 • 0 个评论 • 63 次浏览 • 2022-02-04 19:06

php抓取网页匹配url里的特定字符串,比如,然后生成sqlite数据库。比如把上面这个分词的网页抓取下来。在对应url返回网页中指定字符串处理方式,比如返回一个静态页面。refererheaders里写入xxx.content=xxx.get("");,返回json数据。这样你就知道refererheaders里是什么数据了。

php文件要转换成json。

第一个问题:参考[12]第二个问题:分词本质上不是文本相互转换,可以是字符串相互转换,可以是数组相互转换。

matlab用的是glm,下面是个人看法,大佬们轻喷,随便拍,欢迎喷子,你们想喷啊?最简单的文本相互转换,就是php的glm库,里面有完善的header字段用来匹配mediaquery,还有一个allreduce来处理语句的执行时间,其他的你有兴趣去leesdudao老大的专栏上看看也许会有所启发。要按照你自己的需求去打开一个php的浏览器,里面有一个图形的php框架:/main.asp?param=matlab_simplib::path1简单的解析,遍历post句柄,根据要匹配的文本信息去遍历,然后把这个文本向最后的sent文件那里发送数据,处理完成之后,要把post整个文件处理了把字段matlab内置库很多,有glm有simplemodel,这些框架都可以完成。或者是放大招,把post数据放到hosts里,设置replacement,注册本地库文件。 查看全部

php抓取网页匹配url(php抓取网页匹配url里的特定字符串,比如,然后生成sqlite)

php抓取网页匹配url里的特定字符串,比如,然后生成sqlite数据库。比如把上面这个分词的网页抓取下来。在对应url返回网页中指定字符串处理方式,比如返回一个静态页面。refererheaders里写入xxx.content=xxx.get("");,返回json数据。这样你就知道refererheaders里是什么数据了。

php文件要转换成json。

第一个问题:参考[12]第二个问题:分词本质上不是文本相互转换,可以是字符串相互转换,可以是数组相互转换。

matlab用的是glm,下面是个人看法,大佬们轻喷,随便拍,欢迎喷子,你们想喷啊?最简单的文本相互转换,就是php的glm库,里面有完善的header字段用来匹配mediaquery,还有一个allreduce来处理语句的执行时间,其他的你有兴趣去leesdudao老大的专栏上看看也许会有所启发。要按照你自己的需求去打开一个php的浏览器,里面有一个图形的php框架:/main.asp?param=matlab_simplib::path1简单的解析,遍历post句柄,根据要匹配的文本信息去遍历,然后把这个文本向最后的sent文件那里发送数据,处理完成之后,要把post整个文件处理了把字段matlab内置库很多,有glm有simplemodel,这些框架都可以完成。或者是放大招,把post数据放到hosts里,设置replacement,注册本地库文件。

php抓取网页匹配url(1.介绍的TFUMS项目的配置文件格式的效率不高)

网站优化 • 优采云 发表了文章 • 0 个评论 • 77 次浏览 • 2022-02-04 14:11

1. 简介

1.1 简介

富哥的TFUMS项目的配置文件其实是一个PHP程序文件。虽然使用PHP程序文件作为项目的配置文件更加灵活,但感觉还是差了一点。

Java 项目使用 XML 作为项目的配置文件。XML格式可以容纳更复杂的配置参数,读起来很清晰。但是,PHP 对 XML 格式的文档的读取天生就有点不足,并且无法将 XML 格式转换为 PHP 数组,而且 PHP 解析 XML 格式的效率也不是很高。

PHP语言解析器的配置文件为INI格式。INI格式不如XML格式,能适应更复杂的配置参数,但用起来也够用了。最重要的是PHP解析INI格式非常方便。一个 parse_ini_file 函数 您可以将 INI 文档中的配置参数转换为 PHP 数组。既然是保证效率的内置函数,就这样吧~~

2. PHP格式配置文件

付哥首先给出了当前TFUMS项目的配置文件,这是一个标准的PHP程序文件,通过TFConfig对象设置项目参数。

2.1个配置文件

use TFPHP\Database\SQL\TFDO;

use TFPHP\System\TFLog;

use TFPHP\System\TFConfig;

TFConfig::set("default", array(

'driver'=>TFDO::T_MYSQL,

'host'=>"mysql",

'port'=>3306,

'user'=>"tfums",

'pass'=>"abcdef",

'db'=>"tfums",

'charset'=>"utf8",

), "TFDO");

TFConfig::set("default", array(

'host'=>"redis",

'port'=>6379,

'pass'=>"tongfu.net",

'db'=>"tfums",

), "TFRedis");

TFConfig::set("default", array(

'host'=>"elasticsearch",

'port'=>9200,

'db'=>"tfums"

), "TFElasticsearch");

TFConfig::set("charset", "UTF-8", "system");

TFConfig::set("domain", "192.168.1.168", "system");

TFConfig::set("apiUrl", "http://php-nginx-tfums/api/", "system");

TFConfig::set("outUrl", "http://192.168.1.168/tfums/", "system");

TFConfig::set("baseUri", "/", "system");

TFConfig::set("systemLogLevel", TFLog::T_INFO, "system");

TFConfig::set("projectAESPK", md5("福哥的TFUMS系统基于TFPHP框架"), "system");

TFConfig::set("SMTPArgs", array(

'host'=>"smtp.tongfu.net",

'port'=>25,

'user'=>"tfums@tongfu.net",

'pwd'=>"cba321",

'email'=>"tfums@tongfu.net"

), "system");

TFConfig::set("imageDirArgs", array(

"dirs"=>array(

"img3"=>array(

"path"=>"/tongfu.net/web/TFHomeImg3/",

"requestUri"=>"/img3/"

)

),

"default"=>"img3"

), "system");

TFConfig::set("defaultUserImages", array(

'icon'=>"/images/usericon.jpg",

'style'=>"/images/userstyle.jpg",

), "system");

TFConfig::set("bindEmailTemplateArgs", array(

'subject'=>"亲爱的{userName},请激活你的TFUMS系统账号的绑定邮箱",

'body'=>"亲爱的{userName},你好!

请点击下面的链接完成邮箱绑定操作!

{link}</a>

TFUMS

tfums@tongfu.net

"

), "system");

2.2 数据源

这里面有3个数据源,分别是MySQL数据源、Redis数据源和ES数据源,都是数组的形式。

TFConfig::set("default", array(

'driver'=>TFDO::T_MYSQL,

'host'=>"mysql",

'port'=>3306,

'user'=>"tfums",

'pass'=>"abcdef",

'db'=>"tfums",

'charset'=>"utf8",

), "TFDO");

TFConfig::set("default", array(

'host'=>"redis",

'port'=>6379,

'pass'=>"tongfu.net",

'db'=>"tfums",

), "TFRedis");

TFConfig::set("default", array(

'host'=>"elasticsearch",

'port'=>9200,

'db'=>"tfums"

), "TFElasticsearch");

2.3 环境参数

这里是一个系统环境参数,都是简单的字符串参数。

TFConfig::set("charset", "UTF-8", "system");

TFConfig::set("domain", "192.168.1.168", "system");

TFConfig::set("apiUrl", "http://php-nginx-tfums/api/", "system");

TFConfig::set("outUrl", "http://192.168.1.168/tfums/", "system");

TFConfig::set("baseUri", "/", "system");

TFConfig::set("systemLogLevel", TFLog::T_INFO, "system");

TFConfig::set("projectAESPK", md5("福哥的TFUMS系统基于TFPHP框架"), "system");

2.4 函数参数

函数参数所针对的一些系统函数的参数一般是数组类型的参数,甚至是多级参数。

TFConfig::set("SMTPArgs", array(

'host'=>"smtp.tongfu.net",

'port'=>25,

'user'=>"tfums@tongfu.net",

'pwd'=>"cba321",

'email'=>"tfums@tongfu.net"

), "system");

TFConfig::set("imageDirArgs", array(

"dirs"=>array(

"img3"=>array(

"path"=>"/tongfu.net/web/TFHomeImg3/",

"requestUri"=>"/img3/"

)

),

"default"=>"img3"

), "system");

TFConfig::set("defaultUserImages", array(

'icon'=>"/images/usericon.jpg",

'style'=>"/images/userstyle.jpg",

), "system");

TFConfig::set("bindEmailTemplateArgs", array(

'subject'=>"亲爱的{userName},请激活你的TFUMS系统账号的绑定邮箱",

'body'=>"亲爱的{userName},你好!

请点击下面的链接完成邮箱绑定操作!

{link}</a>

TFUMS

tfums@tongfu.net

"

), "system");

3. INI 格式配置文件

虽然INI格式也可以通过section、key、value实现二维数组结构,但INI格式毕竟没有PHP语言的自由度。所以 Fugo 需要一些技巧来将 TFUMS 项目的配置文件转换为 INI 格式。

3.1 配置文件

[TFDO]

default[driver] = MySQL

default[host] = mysql

default[port] = 3306

default[user] = root

default[pass] = abcdef

default[db] = tfums

default[charset] = utf8

[TFRedis]

default[host] = redis

default[port] = 6379

default[pass] = tongfu.net

default[db] = tfums

[TFElasticsearch]

default[host] = elasticsearch

default[port] = 9200

default[db] = tfums

[system]

charset = UTF-8

domain = 192.168.1.168

apiUrl = http://php-nginx-tfums/api/

outUrl = http://192.168.1.168/tfums/

baseUri = /

systemLogLevel = info

projectAESPK = 86fbd7cec5a89700760c167e85acdab8

imageDirsPath[img3] = /tongfu.net/web/TFHomeImg3/

imageDirsRequestURI[img3] = /img3/

imageDirDefault = img3

SMTP[host] = smtp.tongfu.net

SMTP[port] = 25

SMTP[user] = tfums@tongfu.net

SMTP[pwd] = cba321

SMTP[email] = tfums@tongfu.net

defaultUserImages[icon] = /images/usericon.jpg

defaultUserImages[style] = /images/userstyle.jpg

bindEmailTemplate[subject] = 亲爱的{userName},请激活你的TFUMS系统账号的绑定邮箱

bindEmailTemplate[body] = "亲爱的{userName},你好!

请点击下面的链接完成邮箱绑定操作!

{link}</a>

tfums

tfums@tongfu.net

"

3.2 数据源

INI文档可以通过section和key实现二维数组结构,和PHP的group+array格式一致,没问题!

INI 文档的键也可以使用方括号格式化为数组,parse_ini_file 函数将其转换为数组参数。

[TFDO]

default[driver] = MySQL

default[host] = mysql

default[port] = 3306

default[user] = root

default[pass] = abcdef

default[db] = tfums

default[charset] = utf8

[TFRedis]

default[host] = redis

default[port] = 6379

default[pass] = tongfu.net

default[db] = tfums

[TFElasticsearch]

default[host] = elasticsearch

default[port] = 9200

default[db] = tfums

3.3 环境参数

环境参数 大部分参数都是字符串,可以直接设置。另外 imageDirArgs 是一个多数组,这个 INI 格式不能固定。

富哥的解决方案是将多维数组拆分成多个参数。当然,相应项目中的程序也必须改变。

charset = UTF-8

domain = 192.168.1.168

apiUrl = http://php-nginx-tfums/api/

outUrl = http://192.168.1.168/tfums/

baseUri = /

systemLogLevel = info

projectAESPK = 86fbd7cec5a89700760c167e85acdab8

imageDirArgsPath[img3] = /tongfu.net/web/TFHomeImg3/

imageDirArgsRequestURI[img3] = /img3/

imageDirArgsDefault = img3

3.4 函数参数

函数参数都是一一对应的数组,也可以直接转换。

这里有一种特殊情况,就是邮件模板正文中的多行字符串,需要用双引号括起来,内容中的双引号需要转义。

SMTP[host] = smtp.tongfu.net

SMTP[port] = 25

SMTP[user] = tfums@tongfu.net

SMTP[pwd] = cba321

SMTP[email] = tfums@tongfu.net

defaultUserImages[icon] = /images/usericon.jpg

defaultUserImages[style] = /images/userstyle.jpg

bindEmailTemplate[subject] = 亲爱的{userName},请激活你的TFUMS系统账号的绑定邮箱

bindEmailTemplate[body] = "亲爱的{userName},你好!

请点击下面的链接完成邮箱绑定操作!

{link}</a>

tfums

tfums@tongfu.net

"

3.5 INI 到 PHP 数组

这个比较简单,就是一行代码的事情。

$webIniArr = parse_ini_file(WEB_INF_ROOT_PATH. 'Conf/web.ini', true);

转换后的 PHP 数组的结构如下。

4. 摘要

今天,富哥带着童鞋们,将TFUMS项目的配置文件从PHP格式的程序文件转换为INI格式的文档。使用INI文件后的配置文件看起来更像是一个配置文件。INI 文件更独立,可读性更好。 查看全部

php抓取网页匹配url(1.介绍的TFUMS项目的配置文件格式的效率不高)

1. 简介

1.1 简介

富哥的TFUMS项目的配置文件其实是一个PHP程序文件。虽然使用PHP程序文件作为项目的配置文件更加灵活,但感觉还是差了一点。

Java 项目使用 XML 作为项目的配置文件。XML格式可以容纳更复杂的配置参数,读起来很清晰。但是,PHP 对 XML 格式的文档的读取天生就有点不足,并且无法将 XML 格式转换为 PHP 数组,而且 PHP 解析 XML 格式的效率也不是很高。

PHP语言解析器的配置文件为INI格式。INI格式不如XML格式,能适应更复杂的配置参数,但用起来也够用了。最重要的是PHP解析INI格式非常方便。一个 parse_ini_file 函数 您可以将 INI 文档中的配置参数转换为 PHP 数组。既然是保证效率的内置函数,就这样吧~~

2. PHP格式配置文件

付哥首先给出了当前TFUMS项目的配置文件,这是一个标准的PHP程序文件,通过TFConfig对象设置项目参数。

2.1个配置文件

use TFPHP\Database\SQL\TFDO;

use TFPHP\System\TFLog;

use TFPHP\System\TFConfig;

TFConfig::set("default", array(

'driver'=>TFDO::T_MYSQL,

'host'=>"mysql",

'port'=>3306,

'user'=>"tfums",

'pass'=>"abcdef",

'db'=>"tfums",

'charset'=>"utf8",

), "TFDO");

TFConfig::set("default", array(

'host'=>"redis",

'port'=>6379,

'pass'=>"tongfu.net",

'db'=>"tfums",

), "TFRedis");

TFConfig::set("default", array(

'host'=>"elasticsearch",

'port'=>9200,

'db'=>"tfums"

), "TFElasticsearch");

TFConfig::set("charset", "UTF-8", "system");

TFConfig::set("domain", "192.168.1.168", "system");

TFConfig::set("apiUrl", "http://php-nginx-tfums/api/", "system");

TFConfig::set("outUrl", "http://192.168.1.168/tfums/", "system");

TFConfig::set("baseUri", "/", "system");

TFConfig::set("systemLogLevel", TFLog::T_INFO, "system");

TFConfig::set("projectAESPK", md5("福哥的TFUMS系统基于TFPHP框架"), "system");

TFConfig::set("SMTPArgs", array(

'host'=>"smtp.tongfu.net",

'port'=>25,

'user'=>"tfums@tongfu.net",

'pwd'=>"cba321",

'email'=>"tfums@tongfu.net"

), "system");

TFConfig::set("imageDirArgs", array(

"dirs"=>array(

"img3"=>array(

"path"=>"/tongfu.net/web/TFHomeImg3/",

"requestUri"=>"/img3/"

)

),

"default"=>"img3"

), "system");

TFConfig::set("defaultUserImages", array(

'icon'=>"/images/usericon.jpg",

'style'=>"/images/userstyle.jpg",

), "system");

TFConfig::set("bindEmailTemplateArgs", array(

'subject'=>"亲爱的{userName},请激活你的TFUMS系统账号的绑定邮箱",

'body'=>"亲爱的{userName},你好!

请点击下面的链接完成邮箱绑定操作!

{link}</a>

TFUMS

tfums@tongfu.net

"

), "system");

2.2 数据源

这里面有3个数据源,分别是MySQL数据源、Redis数据源和ES数据源,都是数组的形式。

TFConfig::set("default", array(

'driver'=>TFDO::T_MYSQL,

'host'=>"mysql",

'port'=>3306,

'user'=>"tfums",

'pass'=>"abcdef",

'db'=>"tfums",

'charset'=>"utf8",

), "TFDO");

TFConfig::set("default", array(

'host'=>"redis",

'port'=>6379,

'pass'=>"tongfu.net",

'db'=>"tfums",

), "TFRedis");

TFConfig::set("default", array(

'host'=>"elasticsearch",

'port'=>9200,

'db'=>"tfums"

), "TFElasticsearch");

2.3 环境参数

这里是一个系统环境参数,都是简单的字符串参数。

TFConfig::set("charset", "UTF-8", "system");

TFConfig::set("domain", "192.168.1.168", "system");

TFConfig::set("apiUrl", "http://php-nginx-tfums/api/", "system");

TFConfig::set("outUrl", "http://192.168.1.168/tfums/", "system");

TFConfig::set("baseUri", "/", "system");

TFConfig::set("systemLogLevel", TFLog::T_INFO, "system");

TFConfig::set("projectAESPK", md5("福哥的TFUMS系统基于TFPHP框架"), "system");

2.4 函数参数

函数参数所针对的一些系统函数的参数一般是数组类型的参数,甚至是多级参数。

TFConfig::set("SMTPArgs", array(

'host'=>"smtp.tongfu.net",

'port'=>25,

'user'=>"tfums@tongfu.net",

'pwd'=>"cba321",

'email'=>"tfums@tongfu.net"

), "system");

TFConfig::set("imageDirArgs", array(

"dirs"=>array(

"img3"=>array(

"path"=>"/tongfu.net/web/TFHomeImg3/",

"requestUri"=>"/img3/"

)

),

"default"=>"img3"

), "system");

TFConfig::set("defaultUserImages", array(

'icon'=>"/images/usericon.jpg",

'style'=>"/images/userstyle.jpg",

), "system");

TFConfig::set("bindEmailTemplateArgs", array(

'subject'=>"亲爱的{userName},请激活你的TFUMS系统账号的绑定邮箱",

'body'=>"亲爱的{userName},你好!

请点击下面的链接完成邮箱绑定操作!

{link}</a>

TFUMS

tfums@tongfu.net

"

), "system");

3. INI 格式配置文件

虽然INI格式也可以通过section、key、value实现二维数组结构,但INI格式毕竟没有PHP语言的自由度。所以 Fugo 需要一些技巧来将 TFUMS 项目的配置文件转换为 INI 格式。

3.1 配置文件

[TFDO]

default[driver] = MySQL

default[host] = mysql

default[port] = 3306

default[user] = root

default[pass] = abcdef

default[db] = tfums

default[charset] = utf8

[TFRedis]

default[host] = redis

default[port] = 6379

default[pass] = tongfu.net

default[db] = tfums

[TFElasticsearch]

default[host] = elasticsearch

default[port] = 9200

default[db] = tfums

[system]

charset = UTF-8

domain = 192.168.1.168

apiUrl = http://php-nginx-tfums/api/

outUrl = http://192.168.1.168/tfums/

baseUri = /

systemLogLevel = info

projectAESPK = 86fbd7cec5a89700760c167e85acdab8

imageDirsPath[img3] = /tongfu.net/web/TFHomeImg3/

imageDirsRequestURI[img3] = /img3/

imageDirDefault = img3

SMTP[host] = smtp.tongfu.net

SMTP[port] = 25

SMTP[user] = tfums@tongfu.net

SMTP[pwd] = cba321

SMTP[email] = tfums@tongfu.net

defaultUserImages[icon] = /images/usericon.jpg

defaultUserImages[style] = /images/userstyle.jpg

bindEmailTemplate[subject] = 亲爱的{userName},请激活你的TFUMS系统账号的绑定邮箱

bindEmailTemplate[body] = "亲爱的{userName},你好!

请点击下面的链接完成邮箱绑定操作!

{link}</a>

tfums

tfums@tongfu.net

"

3.2 数据源

INI文档可以通过section和key实现二维数组结构,和PHP的group+array格式一致,没问题!

INI 文档的键也可以使用方括号格式化为数组,parse_ini_file 函数将其转换为数组参数。

[TFDO]

default[driver] = MySQL

default[host] = mysql

default[port] = 3306

default[user] = root

default[pass] = abcdef

default[db] = tfums

default[charset] = utf8

[TFRedis]

default[host] = redis

default[port] = 6379

default[pass] = tongfu.net

default[db] = tfums

[TFElasticsearch]

default[host] = elasticsearch

default[port] = 9200

default[db] = tfums

3.3 环境参数

环境参数 大部分参数都是字符串,可以直接设置。另外 imageDirArgs 是一个多数组,这个 INI 格式不能固定。

富哥的解决方案是将多维数组拆分成多个参数。当然,相应项目中的程序也必须改变。

charset = UTF-8

domain = 192.168.1.168

apiUrl = http://php-nginx-tfums/api/

outUrl = http://192.168.1.168/tfums/

baseUri = /

systemLogLevel = info

projectAESPK = 86fbd7cec5a89700760c167e85acdab8

imageDirArgsPath[img3] = /tongfu.net/web/TFHomeImg3/

imageDirArgsRequestURI[img3] = /img3/

imageDirArgsDefault = img3

3.4 函数参数

函数参数都是一一对应的数组,也可以直接转换。

这里有一种特殊情况,就是邮件模板正文中的多行字符串,需要用双引号括起来,内容中的双引号需要转义。

SMTP[host] = smtp.tongfu.net

SMTP[port] = 25

SMTP[user] = tfums@tongfu.net

SMTP[pwd] = cba321

SMTP[email] = tfums@tongfu.net

defaultUserImages[icon] = /images/usericon.jpg

defaultUserImages[style] = /images/userstyle.jpg

bindEmailTemplate[subject] = 亲爱的{userName},请激活你的TFUMS系统账号的绑定邮箱

bindEmailTemplate[body] = "亲爱的{userName},你好!

请点击下面的链接完成邮箱绑定操作!

{link}</a>

tfums

tfums@tongfu.net

"

3.5 INI 到 PHP 数组

这个比较简单,就是一行代码的事情。

$webIniArr = parse_ini_file(WEB_INF_ROOT_PATH. 'Conf/web.ini', true);

转换后的 PHP 数组的结构如下。

4. 摘要

今天,富哥带着童鞋们,将TFUMS项目的配置文件从PHP格式的程序文件转换为INI格式的文档。使用INI文件后的配置文件看起来更像是一个配置文件。INI 文件更独立,可读性更好。

php抓取网页匹配url(php获取上一个页面的地址可以使用$_SERVER[HTTP_REFERER])

网站优化 • 优采云 发表了文章 • 0 个评论 • 88 次浏览 • 2022-02-02 19:13

php可以使用$_SERVER["HTTP_REFERER"]变量来获取上一页的地址,$_SERVER是php中的环境变量,这个文章会介绍$_SERVER["HTTP_REFERER"的使用],比如有需要的朋友可以参考一下。

php $_SERVER["HTTP_REFERER"] 变量可以获取上一页或上一页的URL地址。

比如有一个a.php页面,这个页面上有一个指向b.php页面的链接。如果我们在a.php页面点击这个链接,此时页面会到达b.php页面。在b.php页面输出$_SERVER["HTTP_REFERER"]变量,结果会显示a.php页面的地址。

如果页面直接在浏览器中打开,不会设置$_SERVER["HTTP_REFERER"],调用$_SERVER["HTTP_REFERER"]变量时会出现如下错误信息:

Notice: Undefined index: HTTP_REFERER in /path/to/filename.php on line 3

为了防止这个错误信息被输出,我们可以使用下面的严格代码:

if(isset($_SERVER['HTTP_REFERER'])) {

echo $_SERVER['HTTP_REFERER'];

}

否则此代码将起作用:

echo isset($_SERVER['HTTP_REFERER']) ? $_SERVER['HTTP_REFERER'] : '';

php $_SERVER["HTTP_REFERER"] 一般用于判断页面的来源,比如下面的例子:

点击我!

从上面的例子可以看出,$_SERVER["HTTP_REFERER"]可以用于网站数据统计。你可以自己试试。 查看全部

php抓取网页匹配url(php获取上一个页面的地址可以使用$_SERVER[HTTP_REFERER])

php可以使用$_SERVER["HTTP_REFERER"]变量来获取上一页的地址,$_SERVER是php中的环境变量,这个文章会介绍$_SERVER["HTTP_REFERER"的使用],比如有需要的朋友可以参考一下。

php $_SERVER["HTTP_REFERER"] 变量可以获取上一页或上一页的URL地址。

比如有一个a.php页面,这个页面上有一个指向b.php页面的链接。如果我们在a.php页面点击这个链接,此时页面会到达b.php页面。在b.php页面输出$_SERVER["HTTP_REFERER"]变量,结果会显示a.php页面的地址。

如果页面直接在浏览器中打开,不会设置$_SERVER["HTTP_REFERER"],调用$_SERVER["HTTP_REFERER"]变量时会出现如下错误信息:

Notice: Undefined index: HTTP_REFERER in /path/to/filename.php on line 3

为了防止这个错误信息被输出,我们可以使用下面的严格代码:

if(isset($_SERVER['HTTP_REFERER'])) {

echo $_SERVER['HTTP_REFERER'];

}

否则此代码将起作用:

echo isset($_SERVER['HTTP_REFERER']) ? $_SERVER['HTTP_REFERER'] : '';

php $_SERVER["HTTP_REFERER"] 一般用于判断页面的来源,比如下面的例子:

点击我!

从上面的例子可以看出,$_SERVER["HTTP_REFERER"]可以用于网站数据统计。你可以自己试试。

php抓取网页匹配url(投个机取个巧吧这是之前的获取远程图片教程 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 78 次浏览 • 2022-01-27 15:22

)

获取远程图片是经常处理的事情。我们可以用curl来处理,性能要高很多。但有时为了提高开发效率,我们必须先实现功能,所以我们来试一试。

这是以前的教程,curl写的,使用包文件

以下是获取图片的最简单方法。适合在流量不是很大,同一个地址的请求也不多的时候使用网站

教程 2

$str = "https://micuer.com/data/upload ... 3B%3B$str = file_get_contents($str);$res = file_put_contents("./22.png",$str);p($res);die;

附:两者的区别

1.fopen /file_get_contents 会为每个请求重新做 DNS 查询,并且不缓存 DNS 信息。但是 CURL 会自动缓存 DNS 信息。对同一域名下的网页或图片的请求只需要一次 DNS 查询。这大大减少了 DNS 查询的数量。所以 CURL 的性能要比 fopen /file_get_contents 好很多。

2.fopen /file_get_contents 请求 HTTP 时,它使用 http_fopen_wrapper,而不是 keeplive。卷曲可以。这样,当多次请求多个链接时,curl 会更高效。

3.fopen / file_get_contents 函数受 php.ini 文件中的 allow_url_open 选项配置影响。如果关闭配置,该功能也会失效。并且 curl 不受此配置的影响。

4.curl可以模拟各种请求,例如:POST数据、表单提交等,用户可以根据自己的需要自定义请求。而 fopen/file_get_contents 只能使用 get 方法获取数据。

file_get_contents 获取远程文件时,结果以字符串形式存储,fiels函数以数组形式存储

附:性能对比

查看全部

php抓取网页匹配url(投个机取个巧吧这是之前的获取远程图片教程

)

获取远程图片是经常处理的事情。我们可以用curl来处理,性能要高很多。但有时为了提高开发效率,我们必须先实现功能,所以我们来试一试。

这是以前的教程,curl写的,使用包文件

以下是获取图片的最简单方法。适合在流量不是很大,同一个地址的请求也不多的时候使用网站

教程 2

$str = "https://micuer.com/data/upload ... 3B%3B$str = file_get_contents($str);$res = file_put_contents("./22.png",$str);p($res);die;

附:两者的区别

1.fopen /file_get_contents 会为每个请求重新做 DNS 查询,并且不缓存 DNS 信息。但是 CURL 会自动缓存 DNS 信息。对同一域名下的网页或图片的请求只需要一次 DNS 查询。这大大减少了 DNS 查询的数量。所以 CURL 的性能要比 fopen /file_get_contents 好很多。

2.fopen /file_get_contents 请求 HTTP 时,它使用 http_fopen_wrapper,而不是 keeplive。卷曲可以。这样,当多次请求多个链接时,curl 会更高效。

3.fopen / file_get_contents 函数受 php.ini 文件中的 allow_url_open 选项配置影响。如果关闭配置,该功能也会失效。并且 curl 不受此配置的影响。

4.curl可以模拟各种请求,例如:POST数据、表单提交等,用户可以根据自己的需要自定义请求。而 fopen/file_get_contents 只能使用 get 方法获取数据。

file_get_contents 获取远程文件时,结果以字符串形式存储,fiels函数以数组形式存储

附:性能对比

php抓取网页匹配url(php抓取网页匹配url返回含有特定内容的html字符串,)

网站优化 • 优采云 发表了文章 • 0 个评论 • 67 次浏览 • 2022-01-26 13:08

php抓取网页匹配url返回含有特定内容的html字符串,php基于特定html字符串来抓取html字符串的格式化方式是参数-r参数1:仅抓取该域名含有特定内容的网页格式化首先要根据蜘蛛爬取方向来确定参数,前面我们有写到搜索引擎蜘蛛爬取时的分为以下几种情况:第一种,主动方向搜索,首先就是设置一个局部的参数,设置为prefix='/'(就是你想分析的方向),当然prefix可以不用设置,如果参数n多也有点麻烦,放在前面应该可以。

方向蜘蛛就会扫描到你网站内有没有返回html字符串,如果有就继续爬取第二种,就是无参数爬取方向,只会顺着你的url爬取到给的html字符串,如果存在就继续爬取。第三种,参数,蜘蛛也爬取不到内容时,例如seo优化不善、个人博客、不属于排名重点的页面,这个时候就要在给网页抓取的参数设置手动定时抓取,也就是修改蜘蛛的网络代理,如果是一对一的抓取,最好使用404(404的上一页)代理,对于服务器提供404代理的来说只要设置net_http_connection即可,但如果是多对多的代理,你就必须设置net_connection=404修改connection之后,要在浏览器设置保存404重定向。

代理方式可以选择其他的multi代理:比如gg(在iis里)和:rb(在apache里),设置方法见→nova代理池。代理池是非常不错的一个设置方式,可以使代理池里的代理自动配置,方便更新更换服务器。第二种,就是自定义抓取方向,就是按照自己的需求,切换到不同的网络,自定义抓取格式,方便后期被抓取的网页直接抓取。

例如蜘蛛抓取到了站点0-9三个siah三个结果,用自定义网络1:1:1方式,就可以切换到1234,然后再切换回0-9进行抓取。第三种,所谓redis,参数也有很多,每个参数的大小一般是100左右,最好就是不要设置太大参数,这样你session会有很多,爬取时蜘蛛会不停的重新开始爬取这个站点,耗费时间,你也会发现最多的信息就是,php文件地址、session地址等。 查看全部

php抓取网页匹配url(php抓取网页匹配url返回含有特定内容的html字符串,)

php抓取网页匹配url返回含有特定内容的html字符串,php基于特定html字符串来抓取html字符串的格式化方式是参数-r参数1:仅抓取该域名含有特定内容的网页格式化首先要根据蜘蛛爬取方向来确定参数,前面我们有写到搜索引擎蜘蛛爬取时的分为以下几种情况:第一种,主动方向搜索,首先就是设置一个局部的参数,设置为prefix='/'(就是你想分析的方向),当然prefix可以不用设置,如果参数n多也有点麻烦,放在前面应该可以。

方向蜘蛛就会扫描到你网站内有没有返回html字符串,如果有就继续爬取第二种,就是无参数爬取方向,只会顺着你的url爬取到给的html字符串,如果存在就继续爬取。第三种,参数,蜘蛛也爬取不到内容时,例如seo优化不善、个人博客、不属于排名重点的页面,这个时候就要在给网页抓取的参数设置手动定时抓取,也就是修改蜘蛛的网络代理,如果是一对一的抓取,最好使用404(404的上一页)代理,对于服务器提供404代理的来说只要设置net_http_connection即可,但如果是多对多的代理,你就必须设置net_connection=404修改connection之后,要在浏览器设置保存404重定向。

代理方式可以选择其他的multi代理:比如gg(在iis里)和:rb(在apache里),设置方法见→nova代理池。代理池是非常不错的一个设置方式,可以使代理池里的代理自动配置,方便更新更换服务器。第二种,就是自定义抓取方向,就是按照自己的需求,切换到不同的网络,自定义抓取格式,方便后期被抓取的网页直接抓取。

例如蜘蛛抓取到了站点0-9三个siah三个结果,用自定义网络1:1:1方式,就可以切换到1234,然后再切换回0-9进行抓取。第三种,所谓redis,参数也有很多,每个参数的大小一般是100左右,最好就是不要设置太大参数,这样你session会有很多,爬取时蜘蛛会不停的重新开始爬取这个站点,耗费时间,你也会发现最多的信息就是,php文件地址、session地址等。

php抓取网页匹配url(php抓取网页匹配url地址中的wikipedia类型去查询的方法)

网站优化 • 优采云 发表了文章 • 0 个评论 • 74 次浏览 • 2022-01-23 21:03

php抓取网页匹配url地址中的wikipedia类型去查询的方法可以使用阿里云管理控制台的url爬虫服务完成。登录管理控制台:注册即可使用,

maxcreaming有一个tcga的mlpaclonecookie上传到githubhttps

我记得注册的时候要填.log我是这么登录github的~github-maxcreaming/tcga-global:tcgaglobal

你可以在登录github的时候选择-without-post/-without-post/来全局上传

我们是这样的tcga-without-post.mp4tcga-without-post.mp4tcga-without-post.mp4

直接在github上搞定

nyan-openinstall|这个工具挺好的,你可以试试,

这个问题,大多数人都觉得是对手机的兼容性的问题,但是其实不是。同样的网页,有多台设备,就会有多种连接方式,最常见的就是socks5与sse的区别,当然很多公司使用了通用的ip通道(如香港与美国)做中转,也不意味着好用;如果你只是从中国电信分享的上网方式连接就更不好用了,仅靠几条不同的宽带线路有什么用?所以其实这并不是个问题。

根据问题:要查询某一段医学专业的查询页面,最直接简单的解决方案是通过nicta:\titanic2\information.jpg\我的计算机获取,下面的代码再进行别的操作(mysql,netbeans,数据库什么的)。可以解决问题,学习机会。 查看全部

php抓取网页匹配url(php抓取网页匹配url地址中的wikipedia类型去查询的方法)

php抓取网页匹配url地址中的wikipedia类型去查询的方法可以使用阿里云管理控制台的url爬虫服务完成。登录管理控制台:注册即可使用,

maxcreaming有一个tcga的mlpaclonecookie上传到githubhttps

我记得注册的时候要填.log我是这么登录github的~github-maxcreaming/tcga-global:tcgaglobal

你可以在登录github的时候选择-without-post/-without-post/来全局上传

我们是这样的tcga-without-post.mp4tcga-without-post.mp4tcga-without-post.mp4

直接在github上搞定

nyan-openinstall|这个工具挺好的,你可以试试,

这个问题,大多数人都觉得是对手机的兼容性的问题,但是其实不是。同样的网页,有多台设备,就会有多种连接方式,最常见的就是socks5与sse的区别,当然很多公司使用了通用的ip通道(如香港与美国)做中转,也不意味着好用;如果你只是从中国电信分享的上网方式连接就更不好用了,仅靠几条不同的宽带线路有什么用?所以其实这并不是个问题。

根据问题:要查询某一段医学专业的查询页面,最直接简单的解决方案是通过nicta:\titanic2\information.jpg\我的计算机获取,下面的代码再进行别的操作(mysql,netbeans,数据库什么的)。可以解决问题,学习机会。

php抓取网页匹配url( 爬虫模拟人对网页的操作方法)

网站优化 • 优采云 发表了文章 • 0 个评论 • 77 次浏览 • 2022-01-13 12:03

爬虫模拟人对网页的操作方法)

使用Python爬取百度热搜信息

目录摘要

前言

什么是爬虫,其实就是用电脑模拟人在网页上的操作

例如,模拟人类浏览和购物网站

使用爬虫前一定要看清楚目标 网站 可罚但不可罚:-)

可以在目标网站中添加/robots.txt,查看网页的具体信息

比如查看天猫的输入

User-agent 代表发送请求的对象

星号 * 代表任何搜索引擎

Disallow 表示不允许访问的部分

/ 表示从根开始

Allow 表示允许访问的部分

在这个例子中,我爬取了百度热搜前30条新闻(我本来打算在英雄联盟首页数据中心爬取前50名英雄的英雄信息,但是无法实现延迟爬取网页的操作,但我只能爬百度热搜),它的一般信息放在Excel表格和Flask网页中,实现数据可视化。对数据可视化感兴趣的同学也可以爬取其他内容

由于我的水平有限,这个文章里面的爬虫都是比较基础的东西

库函数准备

如何安装 Python 库:

打开 cmd 命令提示符并输入 pip install XXX (这是你要安装的库的名称)

这些库的具体使用可以看我接下来的操作

只需要掌握几个常用功能

BS4

即美丽汤

用于解析 HTML 页面并提取指定数据。

后面我的demo里会看到详细的用法。

回覆

用于匹配字符串中的响应字符串的正则表达式。

关于正则表达式,可以去菜鸟教程详细介绍

urllib

它是 Python 自带的 HTTP 请求库,可以操作一系列 URL。

xlwt/xlrt

用于写入(写入)/读取(读取)Excel 表格中的数据。

烧瓶

该库用于制作一个简单的 Web 框架,即 网站 用于数据可视化。

其实我对数据可视化的把握也很浅薄,只是简单的将数据导入到网页中。

神社2

这个库的目的是实现在 HTML 页面的字符中插入参数的功能。

后端:

name="HQ"

前端:

<p>{{name}}长得真帅!

显示:

HQ长得真帅!</p>

标记安全

与 Jinja 一起使用以在渲染页面时避免不受信任的输入,防止注入攻击(尽管没有人会攻击你....)

数据抓取

数据爬取和数据可视化的两个py文件是分开的

数据爬取需要导入re bs4 urllib xlwt的四个库文件

网页抓取

使用下面的方法调用一个函数,让函数调用关系更清晰

if __name__=="__main__": #当程序执行时 调用一下函数

main()

def askurl(url):

head={

"User-Agent":"""Mozilla/5.0 (Windows NT 10.0; Win64; x64)

AppleWebKit/537.36 (KHTML, like Gecko) Chrome/97.0.4692.71 Safari/537.36 Edg/97.0.1072.55"""

}

#用户代理 告诉服务器我只是一个普普通通的浏览器

requset=urllib.request.Request(url)

#发送请求

response=urllib.request.urlopen(requset)

#响应的为一个request对象

#通过read()转化为 bytes类型字符串

#再通过decode()转化为 str类型的字符串

#接受响应

html=response.read().decode("utf-8")

将抓取到的网页存入文档中 方便观察

path=r"C:UsersXXXDesktopPython ext.txt"

#这里在字符串前加入r 防止字符串中的发生转义

f=open(r"path","w",encoding="utf-8")

f.write(html)

f.close()

#这样在txt文件中就可以查看网页的源码

return html

headers的值可以在网页中按F12

然后点击network change,下拉到底部任意request header,就是user-agent代理信息

值得注意的是,如果请求中没有设置headers,服务器会返回418状态码

表示服务器认出你是爬虫,说:“我是茶壶”

表示服务器拒绝煮咖啡,因为它总是一个茶壶(这是一个表情包)

数据分析

把抓到的txt文件后缀改成html作为本地网页打开

如果因为行太长导致vscode报错,可以参考以下博客

打开后的页面如图

使用该功能查看需要爬取信息的地方

在这个项目中,我们抓取目标信息的标题内容和链接

我们可以发现,我们需要的所有信息都在其类为以下类型的表中

所以我们使用 Beautifulsoup 来解析网页

def getData(html):

datalist=[]

soup=BeautifulSoup(html,"html.parser") #定义一个解析对象

#soup.find_all(a,b) 其中a为标签的类型 class_ 对div的class进行匹配

#返回的是所有class为category-wrap_iQLoo horizontal_1eKyQ的列表

for item in soup.find_all("div",class_="category-wrap_iQLoo horizontal_1eKyQ"):

item=str(item)

#将列表中每一个子标签转换为字符串用于re匹配

接下来,重新匹配每个项目

首先使用pile()创建匹配规则,然后使用findall进行匹配

通过查看HTML文件中目标信息前后的特殊字符创建匹配规则

而 (.*?) 是要与 * 匹配的字符串,后跟 ? 代表非贪心匹配

例如

标题前后的信息为省略号">和

其他都一样

<p>#匹配规则

#链接

findlink=re.compile(r" href="(.*?)" rel="external nofollow" target="_blank")

#标题

findtitle=re.compile(r"ellipsis"> (.*?) (.*?) 查看全部

php抓取网页匹配url(

爬虫模拟人对网页的操作方法)

使用Python爬取百度热搜信息

目录摘要

前言

什么是爬虫,其实就是用电脑模拟人在网页上的操作

例如,模拟人类浏览和购物网站

使用爬虫前一定要看清楚目标 网站 可罚但不可罚:-)

可以在目标网站中添加/robots.txt,查看网页的具体信息

比如查看天猫的输入

User-agent 代表发送请求的对象

星号 * 代表任何搜索引擎

Disallow 表示不允许访问的部分

/ 表示从根开始

Allow 表示允许访问的部分

在这个例子中,我爬取了百度热搜前30条新闻(我本来打算在英雄联盟首页数据中心爬取前50名英雄的英雄信息,但是无法实现延迟爬取网页的操作,但我只能爬百度热搜),它的一般信息放在Excel表格和Flask网页中,实现数据可视化。对数据可视化感兴趣的同学也可以爬取其他内容

由于我的水平有限,这个文章里面的爬虫都是比较基础的东西

库函数准备

如何安装 Python 库:

打开 cmd 命令提示符并输入 pip install XXX (这是你要安装的库的名称)

这些库的具体使用可以看我接下来的操作

只需要掌握几个常用功能

BS4

即美丽汤

用于解析 HTML 页面并提取指定数据。

后面我的demo里会看到详细的用法。

回覆

用于匹配字符串中的响应字符串的正则表达式。

关于正则表达式,可以去菜鸟教程详细介绍

urllib

它是 Python 自带的 HTTP 请求库,可以操作一系列 URL。

xlwt/xlrt

用于写入(写入)/读取(读取)Excel 表格中的数据。

烧瓶

该库用于制作一个简单的 Web 框架,即 网站 用于数据可视化。

其实我对数据可视化的把握也很浅薄,只是简单的将数据导入到网页中。

神社2

这个库的目的是实现在 HTML 页面的字符中插入参数的功能。

后端:

name="HQ"

前端:

<p>{{name}}长得真帅!

显示:

HQ长得真帅!</p>

标记安全

与 Jinja 一起使用以在渲染页面时避免不受信任的输入,防止注入攻击(尽管没有人会攻击你....)

数据抓取

数据爬取和数据可视化的两个py文件是分开的

数据爬取需要导入re bs4 urllib xlwt的四个库文件

网页抓取

使用下面的方法调用一个函数,让函数调用关系更清晰

if __name__=="__main__": #当程序执行时 调用一下函数

main()

def askurl(url):

head={

"User-Agent":"""Mozilla/5.0 (Windows NT 10.0; Win64; x64)

AppleWebKit/537.36 (KHTML, like Gecko) Chrome/97.0.4692.71 Safari/537.36 Edg/97.0.1072.55"""

}

#用户代理 告诉服务器我只是一个普普通通的浏览器

requset=urllib.request.Request(url)

#发送请求

response=urllib.request.urlopen(requset)

#响应的为一个request对象

#通过read()转化为 bytes类型字符串

#再通过decode()转化为 str类型的字符串

#接受响应

html=response.read().decode("utf-8")

将抓取到的网页存入文档中 方便观察

path=r"C:UsersXXXDesktopPython ext.txt"

#这里在字符串前加入r 防止字符串中的发生转义

f=open(r"path","w",encoding="utf-8")

f.write(html)

f.close()

#这样在txt文件中就可以查看网页的源码

return html

headers的值可以在网页中按F12

然后点击network change,下拉到底部任意request header,就是user-agent代理信息

值得注意的是,如果请求中没有设置headers,服务器会返回418状态码

表示服务器认出你是爬虫,说:“我是茶壶”

表示服务器拒绝煮咖啡,因为它总是一个茶壶(这是一个表情包)

数据分析

把抓到的txt文件后缀改成html作为本地网页打开

如果因为行太长导致vscode报错,可以参考以下博客

打开后的页面如图

使用该功能查看需要爬取信息的地方

在这个项目中,我们抓取目标信息的标题内容和链接

我们可以发现,我们需要的所有信息都在其类为以下类型的表中

所以我们使用 Beautifulsoup 来解析网页

def getData(html):

datalist=[]

soup=BeautifulSoup(html,"html.parser") #定义一个解析对象

#soup.find_all(a,b) 其中a为标签的类型 class_ 对div的class进行匹配

#返回的是所有class为category-wrap_iQLoo horizontal_1eKyQ的列表

for item in soup.find_all("div",class_="category-wrap_iQLoo horizontal_1eKyQ"):

item=str(item)

#将列表中每一个子标签转换为字符串用于re匹配

接下来,重新匹配每个项目

首先使用pile()创建匹配规则,然后使用findall进行匹配

通过查看HTML文件中目标信息前后的特殊字符创建匹配规则

而 (.*?) 是要与 * 匹配的字符串,后跟 ? 代表非贪心匹配

例如

标题前后的信息为省略号">和

其他都一样

<p>#匹配规则

#链接

findlink=re.compile(r" href="(.*?)" rel="external nofollow" target="_blank")

#标题

findtitle=re.compile(r"ellipsis"> (.*?) (.*?)

php抓取网页匹配url( php中请求url的五种五种方法介绍及详细介绍方法)

网站优化 • 优采云 发表了文章 • 0 个评论 • 73 次浏览 • 2021-12-30 10:15

php中请求url的五种五种方法介绍及详细介绍方法)

php中请求URL的五种方式总结

更新时间:2017年7月13日10:52:47 作者:彼得伯勒的遗书

我在最近的开发中遇到了一个问题。程序的第四行将请求一个 URL。有很多方法可以找到相关信息。本文介绍了 PHP 中使用 fopen() 函数请求 URL 的五种方法。、file()函数、file_get_contents()函数、curl()请求远程url数据和exec()执行命令行命令,一起来看看。

本文主要为大家介绍PHP中请求url的五种方法,分享出来供大家参考学习。话不多说,一起来看看详细介绍:

五种方法:

wget 命令在本地虚拟机上测试请求失败,但在远程服务器上测试成功。考虑到DNS解析的问题,我直接请求了IP,成功下载了index.html文件。

这里仅提供方法,其优缺点需要详细了解每种方法的功能和缺陷。

一、fopen() 函数

$file = fopen("https://www.jb51.net", "r") or die("打开远程文件失败!");

while (!feof($file)) {

$line = fgets($file, 1024);

//使用正则匹配标题标记

if (preg_match("/(.*)/i", $line, $out)) {

$title = $out[1]; //将标题标记中的标题字符取出

break; //退出循环,结束远程文件读取

}

}

fclose($file);

二、file() 函数

$lines = file("https://www.jb51.net/article/48866.htm");

readfile(https://www.jb51.net/article/48866.htm);

三、file_get_contents() 函数

$content = file_get_contents(https://www.jb51.net/article/48866.htm);

四、curl() 请求远程url数据

$url = "http://www.baidu.com";

$ch = curl_init();

$timeout = 5;

curl_setopt($ch, CURLOPT_URL, $url);

curl_setopt($ch, CURLOPT_RETURNTRANSFER, 1);

curl_setopt($ch, CURLOPT_CONNECTTIMEOUT, $timeout);

$contents = curl_exec($ch);

curl_close($ch);

五、exec() 执行命令行命令

//exec("wget 220.181.111.188");

shell_exec("wget 220.181.111.188");

总结

以上是本文的全部内容。希望本文的内容对大家的学习或工作有所帮助。有什么问题可以留言交流。感谢您对 Scripthome 的支持。

相关文章 查看全部

php抓取网页匹配url(

php中请求url的五种五种方法介绍及详细介绍方法)

php中请求URL的五种方式总结

更新时间:2017年7月13日10:52:47 作者:彼得伯勒的遗书

我在最近的开发中遇到了一个问题。程序的第四行将请求一个 URL。有很多方法可以找到相关信息。本文介绍了 PHP 中使用 fopen() 函数请求 URL 的五种方法。、file()函数、file_get_contents()函数、curl()请求远程url数据和exec()执行命令行命令,一起来看看。

本文主要为大家介绍PHP中请求url的五种方法,分享出来供大家参考学习。话不多说,一起来看看详细介绍:

五种方法:

wget 命令在本地虚拟机上测试请求失败,但在远程服务器上测试成功。考虑到DNS解析的问题,我直接请求了IP,成功下载了index.html文件。

这里仅提供方法,其优缺点需要详细了解每种方法的功能和缺陷。

一、fopen() 函数

$file = fopen("https://www.jb51.net", "r") or die("打开远程文件失败!");

while (!feof($file)) {

$line = fgets($file, 1024);

//使用正则匹配标题标记

if (preg_match("/(.*)/i", $line, $out)) {

$title = $out[1]; //将标题标记中的标题字符取出

break; //退出循环,结束远程文件读取

}

}

fclose($file);

二、file() 函数

$lines = file("https://www.jb51.net/article/48866.htm";);

readfile(https://www.jb51.net/article/48866.htm);

三、file_get_contents() 函数

$content = file_get_contents(https://www.jb51.net/article/48866.htm);

四、curl() 请求远程url数据

$url = "http://www.baidu.com";

$ch = curl_init();

$timeout = 5;

curl_setopt($ch, CURLOPT_URL, $url);

curl_setopt($ch, CURLOPT_RETURNTRANSFER, 1);

curl_setopt($ch, CURLOPT_CONNECTTIMEOUT, $timeout);

$contents = curl_exec($ch);

curl_close($ch);

五、exec() 执行命令行命令

//exec("wget 220.181.111.188");

shell_exec("wget 220.181.111.188");

总结

以上是本文的全部内容。希望本文的内容对大家的学习或工作有所帮助。有什么问题可以留言交流。感谢您对 Scripthome 的支持。

相关文章

php抓取网页匹配url(小拽利用php的spider代码和用户dashboard的展现代码)

网站优化 • 优采云 发表了文章 • 0 个评论 • 75 次浏览 • 2021-12-29 01:18

背景说明:小野使用PHP的curl编写的爬虫实验性爬取知乎5w用户的基本信息;同时对爬取的数据进行简单的分析和呈现。

php的爬虫代码和用户仪表盘的显示代码整理上传到github,代码库更新在个人博客和公众号。本节目仅供娱乐学习交流使用;如有侵犯知乎相关权益的,请尽快联系我删除。

无图,无真相

手机分析数据截图

PC端分析数据截图

整个爬取、分析、呈现的过程大致分为以下几个步骤,小燕将分别介绍

curl爬取知乎网页数据规律分析知乎网页数据数据存储与程序部署数据分析与呈现

curl 抓取网页数据

PHP 的 curl 扩展是 PHP 支持的库,允许您使用各种类型的协议与各种服务器进行连接和通信。它是一个非常方便的网页抓取工具,同时支持多线程扩展。

本程序抓取知乎提供给用户访问的个人信息页面。爬取过程需要携带用户cookies来获取页面。直接上传

获取页面cookie

// 登录知乎,打开个人中心,打开控制台,获取cookie

document.cookie

"_za=67254197-3wwb8d-43f6-94f0-fb0e2d521c31; _ga=GA1.2.2142818188.1433767929; q_c1=78ee1604225d47d08cddd8142a08288b23|1452172601000|1452172601000; _xsrf=15f0639cbe6fb607560c075269064393; cap_id="N2QwMTExNGQ0YTY2NGVddlMGIyNmQ4NjdjOTU0YTM5MmQ=|1453444256|49fdc6b43dc51f702b7d6575451e228f56cdaf5d"; __utmt=1; unlock_ticket="QUJDTWpmM0lsZdd2dYQUFBQVlRSlZUVTNVb1ZaNDVoQXJlblVmWGJ0WGwyaHlDdVdscXdZU1VRPT0=|1453444421|c47a2afde1ff334d416bafb1cc267b41014c9d5f"; __utma=51854390.21428dd18188.1433767929.1453187421.1453444257.3; __utmb=51854390.14.8.1453444425011; __utmc=51854390; __utmz=51854390.1452846679.1.dd1.utmcsr=google|utmccn=(organic)|utmcmd=organic|utmctr=(not%20provided); __utmv=51854390.100-1|2=registration_date=20150823=1^dd3=entry_date=20150823=1"

获取个人资料页面

通过curl,扛cookie,先抢我的中心页

/**

* 通过用户名抓取个人中心页面并存储

*

* @param $username str :用户名 flag

* @return boolean :成功与否标志

*/

public function spiderUser($username)

{

$cookie = "xxxx" ;

$url_info = 'http://www.zhihu.com/people/' . $username; //此处cui-xiao-zhuai代表用户ID,可以直接看url获取本人id

$ch = curl_init($url_info); //初始化会话

curl_setopt($ch, CURLOPT_HEADER, 0);

curl_setopt($ch, CURLOPT_COOKIE, $cookie); //设置请求COOKIE

curl_setopt($ch, CURLOPT_USERAGENT, $_SERVER['HTTP_USER_AGENT']);

curl_setopt($ch, CURLOPT_RETURNTRANSFER, 1); //将curl_exec()获取的信息以文件流的形式返回,而不是直接输出。

curl_setopt($ch, CURLOPT_FOLLOWLOCATION, 1);

$result = curl_exec($ch);

file_put_contents('/home/work/zxdata_ch/php/zhihu_spider/file/'.$username.'.html',$result);

return true;

}

定期分析网页数据分析新链接,进一步爬取

对于已爬取的网页的存储,为了进行进一步的爬取,页面必须收录

可用于进一步爬取用户的链接。通过知乎页面的分析,发现个人中心页面有关注者和一些喜欢和关注者。

如下

// 抓取的html页面中发现了新的用户,可用于爬虫

<a class="zm-item-link-avatar avatar-link" href="/people/new-user" data-tip="p$t$new-user">

ok,那你就可以用自己-》关注人-》关注人关注人-》... 不断爬行,下一步就是通过正则匹配提取信息

// 匹配到抓取页面的所有用户

preg_match_all('/\/people\/([\w-]+)\"/i', $str, $match_arr);

// 去重合并入新的用户数组,用户进一步抓取

self::$newUserArr = array_unique(array_merge($match_arr[1], self::$newUserArr));

至此,整个爬取过程就可以顺利进行了。

如果需要大量爬取数据,可以研究curl_multi和pcntl进行快速多线程爬取,这里不再赘述。

分析用户数据并提供分析

通过正则化,可以进一步匹配更多的用户数据,直接进行编码。

// 获取用户头像

preg_match('//i', $str, $match_img);

$img_url = $match_img[1];

// 匹配用户名:

// 崔小拽

preg_match('/([\x{4e00}-\x{9fa5}]+).+span>/u', $str, $match_name);

$user_name = $match_name[1];

// 匹配用户简介

// class bio span 中文

preg_match('/([\x{4e00}-\x{9fa5}]+).+span>/u', $str, $match_title);

$user_title = $match_title[1];

// 匹配性别

// 男

// gender value1 ;结束 中文

preg_match('/<strong>(\d+)\s.+strong>/i', $str, $match_topic);

$user_topic = $match_topic[1];

// 关注人数

// 关注了

preg_match_all('/<strong>(\d+)(\d+)/i', $str, $match_browse);

$user_browse = $match_browse[1];

在爬取过程中,如果条件允许,必须通过redis进行存储,确实可以提高爬取和存储的效率。如果没有条件,只能通过sql进行优化。这里有一些衷心的消息。

在数据库表上设计索引时必须小心。在蜘蛛爬取的过程中,建议将用户名列出来,左右字段不要索引,包括主键,这样尽可能提高存储效率。想象一下5000w的数据,每次加一个,建一个索引需要多少消耗。当爬取完成,需要分析数据时,分批建立索引。

数据存储和更新操作必须是批处理的。mysql给出的增删改查建议和速度:

# 官方的最优批量插入

INSERT INTO yourtable VALUES (1,2), (5,5), ...;

部署操作。程序在爬取过程中可能会异常挂起。为了保证高效率和稳定性,尽量写一个定时脚本。每隔一段时间杀掉它再运行一次,这样即使异常挂起,也不会浪费太多宝贵的时间。毕竟时间就是金钱。

#!/bin/bash

# 干掉

ps aux |grep spider |awk '{print $2}'|xargs kill -9

sleep 5s

# 重新跑

nohup /home/cuixiaohuan/lamp/php5/bin/php /home/cuixiaohuan/php/zhihu_spider/spider_new.php &

数据分析演示

数据展示主要使用echarts3.0,感觉兼容移动端。移动端兼容页面响应式布局主要是通过几个简单的css来控制,代码如下

// 获取用户头像

preg_match('//i', $str, $match_img);

$img_url = $match_img[1];

// 匹配用户名:

// 崔小拽

preg_match('/([\x{4e00}-\x{9fa5}]+).+span>/u', $str, $match_name);

$user_name = $match_name[1];

// 匹配用户简介

// class bio span 中文

preg_match('/([\x{4e00}-\x{9fa5}]+).+span>/u', $str, $match_title);

$user_title = $match_title[1];

// 匹配性别

// 男

// gender value1 ;结束 中文

preg_match('/<strong>(\d+)\s.+strong>/i', $str, $match_topic);

$user_topic = $match_topic[1];

// 关注人数

// 关注了

preg_match_all('/<strong>(\d+)(\d+)/i', $str, $match_browse);

$user_browse = $match_browse[1];

不足,有待学习

整个过程涉及到php、shell、js、css、html、regular等语言和部署基础知识,但还有很多需要改进的地方,小燕特此记录,后续补充示例:

php 使用 multicul 进行多线程。定期匹配进一步优化了部署和爬取过程。Redis用于提高存储和移动端布局的兼容性,提高js的模块化和在sass中编写css。 查看全部

php抓取网页匹配url(小拽利用php的spider代码和用户dashboard的展现代码)

背景说明:小野使用PHP的curl编写的爬虫实验性爬取知乎5w用户的基本信息;同时对爬取的数据进行简单的分析和呈现。

php的爬虫代码和用户仪表盘的显示代码整理上传到github,代码库更新在个人博客和公众号。本节目仅供娱乐学习交流使用;如有侵犯知乎相关权益的,请尽快联系我删除。

无图,无真相

手机分析数据截图

PC端分析数据截图

整个爬取、分析、呈现的过程大致分为以下几个步骤,小燕将分别介绍

curl爬取知乎网页数据规律分析知乎网页数据数据存储与程序部署数据分析与呈现

curl 抓取网页数据

PHP 的 curl 扩展是 PHP 支持的库,允许您使用各种类型的协议与各种服务器进行连接和通信。它是一个非常方便的网页抓取工具,同时支持多线程扩展。

本程序抓取知乎提供给用户访问的个人信息页面。爬取过程需要携带用户cookies来获取页面。直接上传

获取页面cookie

// 登录知乎,打开个人中心,打开控制台,获取cookie

document.cookie

"_za=67254197-3wwb8d-43f6-94f0-fb0e2d521c31; _ga=GA1.2.2142818188.1433767929; q_c1=78ee1604225d47d08cddd8142a08288b23|1452172601000|1452172601000; _xsrf=15f0639cbe6fb607560c075269064393; cap_id="N2QwMTExNGQ0YTY2NGVddlMGIyNmQ4NjdjOTU0YTM5MmQ=|1453444256|49fdc6b43dc51f702b7d6575451e228f56cdaf5d"; __utmt=1; unlock_ticket="QUJDTWpmM0lsZdd2dYQUFBQVlRSlZUVTNVb1ZaNDVoQXJlblVmWGJ0WGwyaHlDdVdscXdZU1VRPT0=|1453444421|c47a2afde1ff334d416bafb1cc267b41014c9d5f"; __utma=51854390.21428dd18188.1433767929.1453187421.1453444257.3; __utmb=51854390.14.8.1453444425011; __utmc=51854390; __utmz=51854390.1452846679.1.dd1.utmcsr=google|utmccn=(organic)|utmcmd=organic|utmctr=(not%20provided); __utmv=51854390.100-1|2=registration_date=20150823=1^dd3=entry_date=20150823=1"

获取个人资料页面

通过curl,扛cookie,先抢我的中心页

/**

* 通过用户名抓取个人中心页面并存储

*

* @param $username str :用户名 flag

* @return boolean :成功与否标志

*/

public function spiderUser($username)

{

$cookie = "xxxx" ;

$url_info = 'http://www.zhihu.com/people/' . $username; //此处cui-xiao-zhuai代表用户ID,可以直接看url获取本人id

$ch = curl_init($url_info); //初始化会话

curl_setopt($ch, CURLOPT_HEADER, 0);

curl_setopt($ch, CURLOPT_COOKIE, $cookie); //设置请求COOKIE

curl_setopt($ch, CURLOPT_USERAGENT, $_SERVER['HTTP_USER_AGENT']);

curl_setopt($ch, CURLOPT_RETURNTRANSFER, 1); //将curl_exec()获取的信息以文件流的形式返回,而不是直接输出。

curl_setopt($ch, CURLOPT_FOLLOWLOCATION, 1);

$result = curl_exec($ch);

file_put_contents('/home/work/zxdata_ch/php/zhihu_spider/file/'.$username.'.html',$result);

return true;

}

定期分析网页数据分析新链接,进一步爬取

对于已爬取的网页的存储,为了进行进一步的爬取,页面必须收录

可用于进一步爬取用户的链接。通过知乎页面的分析,发现个人中心页面有关注者和一些喜欢和关注者。

如下

// 抓取的html页面中发现了新的用户,可用于爬虫

<a class="zm-item-link-avatar avatar-link" href="/people/new-user" data-tip="p$t$new-user">

ok,那你就可以用自己-》关注人-》关注人关注人-》... 不断爬行,下一步就是通过正则匹配提取信息

// 匹配到抓取页面的所有用户

preg_match_all('/\/people\/([\w-]+)\"/i', $str, $match_arr);

// 去重合并入新的用户数组,用户进一步抓取

self::$newUserArr = array_unique(array_merge($match_arr[1], self::$newUserArr));

至此,整个爬取过程就可以顺利进行了。

如果需要大量爬取数据,可以研究curl_multi和pcntl进行快速多线程爬取,这里不再赘述。

分析用户数据并提供分析

通过正则化,可以进一步匹配更多的用户数据,直接进行编码。

// 获取用户头像

preg_match('//i', $str, $match_img);

$img_url = $match_img[1];

// 匹配用户名:

// 崔小拽

preg_match('/([\x{4e00}-\x{9fa5}]+).+span>/u', $str, $match_name);

$user_name = $match_name[1];

// 匹配用户简介

// class bio span 中文

preg_match('/([\x{4e00}-\x{9fa5}]+).+span>/u', $str, $match_title);

$user_title = $match_title[1];

// 匹配性别

// 男

// gender value1 ;结束 中文

preg_match('/<strong>(\d+)\s.+strong>/i', $str, $match_topic);

$user_topic = $match_topic[1];

// 关注人数

// 关注了

preg_match_all('/<strong>(\d+)(\d+)/i', $str, $match_browse);

$user_browse = $match_browse[1];

在爬取过程中,如果条件允许,必须通过redis进行存储,确实可以提高爬取和存储的效率。如果没有条件,只能通过sql进行优化。这里有一些衷心的消息。

在数据库表上设计索引时必须小心。在蜘蛛爬取的过程中,建议将用户名列出来,左右字段不要索引,包括主键,这样尽可能提高存储效率。想象一下5000w的数据,每次加一个,建一个索引需要多少消耗。当爬取完成,需要分析数据时,分批建立索引。

数据存储和更新操作必须是批处理的。mysql给出的增删改查建议和速度:

# 官方的最优批量插入

INSERT INTO yourtable VALUES (1,2), (5,5), ...;

部署操作。程序在爬取过程中可能会异常挂起。为了保证高效率和稳定性,尽量写一个定时脚本。每隔一段时间杀掉它再运行一次,这样即使异常挂起,也不会浪费太多宝贵的时间。毕竟时间就是金钱。

#!/bin/bash

# 干掉

ps aux |grep spider |awk '{print $2}'|xargs kill -9

sleep 5s

# 重新跑

nohup /home/cuixiaohuan/lamp/php5/bin/php /home/cuixiaohuan/php/zhihu_spider/spider_new.php &

数据分析演示

数据展示主要使用echarts3.0,感觉兼容移动端。移动端兼容页面响应式布局主要是通过几个简单的css来控制,代码如下

// 获取用户头像

preg_match('//i', $str, $match_img);

$img_url = $match_img[1];

// 匹配用户名:

// 崔小拽

preg_match('/([\x{4e00}-\x{9fa5}]+).+span>/u', $str, $match_name);

$user_name = $match_name[1];

// 匹配用户简介

// class bio span 中文

preg_match('/([\x{4e00}-\x{9fa5}]+).+span>/u', $str, $match_title);

$user_title = $match_title[1];

// 匹配性别

// 男

// gender value1 ;结束 中文

preg_match('/<strong>(\d+)\s.+strong>/i', $str, $match_topic);

$user_topic = $match_topic[1];

// 关注人数

// 关注了

preg_match_all('/<strong>(\d+)(\d+)/i', $str, $match_browse);

$user_browse = $match_browse[1];

不足,有待学习

整个过程涉及到php、shell、js、css、html、regular等语言和部署基础知识,但还有很多需要改进的地方,小燕特此记录,后续补充示例:

php 使用 multicul 进行多线程。定期匹配进一步优化了部署和爬取过程。Redis用于提高存储和移动端布局的兼容性,提高js的模块化和在sass中编写css。

php抓取网页匹配url(php获取url及其他参数的具体代码示例如下:)

网站优化 • 优采云 发表了文章 • 0 个评论 • 78 次浏览 • 2021-12-28 01:19

下面讨论使用PHP获取当前页面所有url参数信息的相关教程案例和代码教程文章。内容为本站精心挑选整理的教程。希望对广大网友有所帮助。以下是详细内容:

本文教你使用PHP获取当前页面所有url参数信息的教程案例和代码。

php获取url等参数的具体代码示例如下:

一、获取域名或主机地址

echo $_SERVER['HTTP_HOST']."

"; #localhost

二、获取网址

echo $_SERVER['PHP_SELF']."

"; #/blog/testurl.php

三、获取网址参数

echo $_SERVER["QUERY_STRING"]."

"; #id=5

四、获取完整的url

echo 'http://'.$_SERVER['HTTP_HOST'].$_SERVER['REQUEST_URI'];

echo 'http://'.$_SERVER['HTTP_HOST'].$_SERVER['PHP_SELF'].'?'.$_SERVER['QUERY_STRING'];

#http://localhost/blog/testurl.php?id=5

五、获取收录

端口号的完整url

echo 'http://'.$_SERVER['SERVER_NAME'].':'.$_SERVER["SERVER_PORT"].$_SERVER["REQUEST_URI"];

#http://localhost:80/blog/testurl.php?id=5

六、仅获取路径

$url='http://'.$_SERVER['SERVER_NAME'].$_SERVER["REQUEST_URI"];

echo dirname($url);

#http://localhost/blog

注意:$_SERVER 是一个收录

标头、路径和脚本位置等信息的数组。此数组中的项目由 Web 服务器创建。不能保证每个服务器都会提供所有物品;服务器可能会忽略某些或提供此处未列出的某些项目。

使用PHP获取当前页面所有url参数信息的教程案例和代码文章在这里。欢迎浏览本站其他内容,点此返回首页

更多关于的文章 查看全部

php抓取网页匹配url(php获取url及其他参数的具体代码示例如下:)

下面讨论使用PHP获取当前页面所有url参数信息的相关教程案例和代码教程文章。内容为本站精心挑选整理的教程。希望对广大网友有所帮助。以下是详细内容:

本文教你使用PHP获取当前页面所有url参数信息的教程案例和代码。

php获取url等参数的具体代码示例如下:

一、获取域名或主机地址

echo $_SERVER['HTTP_HOST']."

"; #localhost

二、获取网址

echo $_SERVER['PHP_SELF']."

"; #/blog/testurl.php

三、获取网址参数

echo $_SERVER["QUERY_STRING"]."

"; #id=5

四、获取完整的url

echo 'http://'.$_SERVER['HTTP_HOST'].$_SERVER['REQUEST_URI'];

echo 'http://'.$_SERVER['HTTP_HOST'].$_SERVER['PHP_SELF'].'?'.$_SERVER['QUERY_STRING'];

#http://localhost/blog/testurl.php?id=5

五、获取收录

端口号的完整url

echo 'http://'.$_SERVER['SERVER_NAME'].':'.$_SERVER["SERVER_PORT"].$_SERVER["REQUEST_URI"];

#http://localhost:80/blog/testurl.php?id=5

六、仅获取路径

$url='http://'.$_SERVER['SERVER_NAME'].$_SERVER["REQUEST_URI"];

echo dirname($url);

#http://localhost/blog

注意:$_SERVER 是一个收录

标头、路径和脚本位置等信息的数组。此数组中的项目由 Web 服务器创建。不能保证每个服务器都会提供所有物品;服务器可能会忽略某些或提供此处未列出的某些项目。

使用PHP获取当前页面所有url参数信息的教程案例和代码文章在这里。欢迎浏览本站其他内容,点此返回首页

更多关于的文章

php抓取网页匹配url( 2016年11月23日10:44:18字符串匹配的模式)

网站优化 • 优采云 发表了文章 • 0 个评论 • 66 次浏览 • 2021-12-24 10:04

2016年11月23日10:44:18字符串匹配的模式)

正则表达式匹配URL(推荐)

更新时间:2016年11月23日10:44:18 作者:Kris゜

正则表达式描述了一种字符串匹配模式。本文重点介绍匹配URL的正则表达式,感兴趣的朋友可以一起学习

正则表达式描述了字符串匹配的一种模式,可用于检查字符串是否收录某个子字符串,替换匹配的子字符串,或者从字符串中提取满足某个条件的子字符串等等。

正则表达式:

var match = /^((ht|f)tps?):\/\/[\w\-]+(\.[\w\-]+)+([\w\-\.,@?^=%&:\/~\+#]*[\w\-\@?^=%&\/~\+#])?$/;

比赛:

(1),直接匹配域名地址:

var matchString = 'https://i.cnblogs.com/';

console.log(match.test(matchString)); // ==> true

(2), 匹配带有 (*.htm,*.html,*.php,*.aspx...) 后缀地址的链接:

var matchString = 'https://i.cnblogs.com/EditPosts.aspx';

console.log(match.test(matchString)); // ==> true

(3),带参数匹配地址:

var matchString = 'https://i.cnblogs.com/EditPosts.aspx?opt=1';

console.log(match.test(matchString)); // ==> true

使用说明: 查看全部

php抓取网页匹配url(

2016年11月23日10:44:18字符串匹配的模式)

正则表达式匹配URL(推荐)

更新时间:2016年11月23日10:44:18 作者:Kris゜

正则表达式描述了一种字符串匹配模式。本文重点介绍匹配URL的正则表达式,感兴趣的朋友可以一起学习

正则表达式描述了字符串匹配的一种模式,可用于检查字符串是否收录某个子字符串,替换匹配的子字符串,或者从字符串中提取满足某个条件的子字符串等等。

正则表达式:

var match = /^((ht|f)tps?):\/\/[\w\-]+(\.[\w\-]+)+([\w\-\.,@?^=%&:\/~\+#]*[\w\-\@?^=%&\/~\+#])?$/;

比赛:

(1),直接匹配域名地址:

var matchString = 'https://i.cnblogs.com/';

console.log(match.test(matchString)); // ==> true

(2), 匹配带有 (*.htm,*.html,*.php,*.aspx...) 后缀地址的链接:

var matchString = 'https://i.cnblogs.com/EditPosts.aspx';

console.log(match.test(matchString)); // ==> true

(3),带参数匹配地址:

var matchString = 'https://i.cnblogs.com/EditPosts.aspx?opt=1';

console.log(match.test(matchString)); // ==> true

使用说明:

php抓取网页匹配url(php抓取网页匹配url拼接bufferfromscrapyimportloginfromscrapy)

网站优化 • 优采云 发表了文章 • 0 个评论 • 65 次浏览 • 2021-12-22 10:12

php抓取网页匹配url拼接buffer

fromscrapyimportloginfromscrapy。exceptionsimportdebugimportrequestimportrewb=request。urlopen(";cid=")item=item['key']ws=wb。parse(request。url)print("数据结构")print("正在向服务器获取数据")ifws。

get("/")!="/":print("未发起异步请求")ifpython。debug。error('异步请求'):print("请求报文")else:print("请求报文")。

ajax那个xmlhttprequest不会抓。

xmlhttprequest只会在服务器端执行,你需要一个控制台返回可写item。

xmlhttprequest不能处理xml的读写

xmlhttprequest是xml对象的list,把xml对象转成list形式。

xmlhttprequest这玩意用过mvc么?

xmlhttprequest,xmlhttprequest是xml对象的list,把xml对象转成list形式。把list转成list必须用xmlhttprequest.xmlhttprequest.urlforward()。

http的实现中会有一种accept方法,参数是一个描述url接口的字符串,可以用来捕获异步请求,用法类似于异步i/o.详细内容可以参照tornado或者kafka等。 查看全部

php抓取网页匹配url(php抓取网页匹配url拼接bufferfromscrapyimportloginfromscrapy)

php抓取网页匹配url拼接buffer

fromscrapyimportloginfromscrapy。exceptionsimportdebugimportrequestimportrewb=request。urlopen(";cid=")item=item['key']ws=wb。parse(request。url)print("数据结构")print("正在向服务器获取数据")ifws。

get("/")!="/":print("未发起异步请求")ifpython。debug。error('异步请求'):print("请求报文")else:print("请求报文")。

ajax那个xmlhttprequest不会抓。

xmlhttprequest只会在服务器端执行,你需要一个控制台返回可写item。

xmlhttprequest不能处理xml的读写

xmlhttprequest是xml对象的list,把xml对象转成list形式。

xmlhttprequest这玩意用过mvc么?

xmlhttprequest,xmlhttprequest是xml对象的list,把xml对象转成list形式。把list转成list必须用xmlhttprequest.xmlhttprequest.urlforward()。

http的实现中会有一种accept方法,参数是一个描述url接口的字符串,可以用来捕获异步请求,用法类似于异步i/o.详细内容可以参照tornado或者kafka等。

php抓取网页匹配url(php一个类无需扩支持服务器的特点及下载地址介绍)

网站优化 • 优采云 发表了文章 • 0 个评论 • 61 次浏览 • 2021-12-10 07:20

Snoopy是一个php类,用来模拟浏览器的功能,可以获取网页的内容,并发送表单。

下载链接:

史努比的一些特点:

1 fetch 网页内容 fetch

2 获取网页的文本内容(去除HTML标签)fetchtext

3 获取网页链接,表单 fetchlinks fetchform

4 支持代理主机

5 支持基本的用户名/密码验证

6 支持设置user_agent、referer(传入路由)、cookies和header内容(头文件)

7 支持浏览器重定向,可以控制重定向的深度

8 可以将网页中的链接扩展为高质量的url(默认)

9 提交数据并获取返回值

10 支持跟踪 HTML 框架

11 支持重定向时传递 cookie

需要 php4 或更高版本。既然是php的一个类,就不需要扩展支持了。服务器不支持curl时的最佳选择,

类方法:

获取($URI)

————

这是用于抓取网页内容的方法。

$URI 参数是被抓取网页的 URL 地址。

获取的结果存储在 $this->results 中。

如果你正在抓取一个帧,史努比会跟踪每一帧并将其存储在一个数组中,然后将其存储在 $this->results 中。

fetchtext($URI)

—————

该方法与fetch()类似,唯一不同的是该方法会去除HTML标签等无关数据,只返回网页中的文本内容。

fetchform($URI)

—————

该方法与fetch()类似,唯一不同的是该方法会去除HTML标签等无关数据,只返回网页中的表单内容(form)。

fetchlinks($URI)

—————-

该方法与fetch()类似,唯一不同的是,该方法会去除HTML标签等无关数据,只返回网页中的链接。

默认情况下,相对链接会自动补全并转换成完整的网址。

提交($URI,$formvars)

———————-

此方法向$URL 指定的链接地址发送确认表单。 $formvars 是一个存储表单参数的数组。

提交文本($URI,$formvars)

——————————

该方法与submit()类似,唯一不同的是,该方法会去除HTML标签等无关数据,登录后只返回网页中的文本内容。

提交链接($URI)

—————-

该方法与submit()类似,唯一不同的是,该方法会去除HTML标签等无关数据,只返回网页中的链接。

默认情况下,相对链接会自动补全并转换成完整的网址。

类属性:(括号内为默认值)

$host 连接的主机

$port 连接的端口

$proxy_host 使用的代理主机,如果有的话

$proxy_port 使用的代理主机端口,如果有的话

$agent 用户代理伪装(史努比 v0.1)

$referer 传入信息,如果有的话

$cookies cookies,如果有的话

$rawheaders 其他头信息,如果有的话

$maxredirs 最大重定向次数,0=不允许 (5)

$offsiteok 是否允许异地重定向。 (真)

$expandlinks 是否完成所有链接以完成地址(真实)

$user 认证用户名,如果有的话

$pass 认证用户名,如果有的话 查看全部

php抓取网页匹配url(php一个类无需扩支持服务器的特点及下载地址介绍)

Snoopy是一个php类,用来模拟浏览器的功能,可以获取网页的内容,并发送表单。

下载链接:

史努比的一些特点:

1 fetch 网页内容 fetch

2 获取网页的文本内容(去除HTML标签)fetchtext

3 获取网页链接,表单 fetchlinks fetchform

4 支持代理主机

5 支持基本的用户名/密码验证

6 支持设置user_agent、referer(传入路由)、cookies和header内容(头文件)

7 支持浏览器重定向,可以控制重定向的深度

8 可以将网页中的链接扩展为高质量的url(默认)

9 提交数据并获取返回值

10 支持跟踪 HTML 框架

11 支持重定向时传递 cookie

需要 php4 或更高版本。既然是php的一个类,就不需要扩展支持了。服务器不支持curl时的最佳选择,

类方法:

获取($URI)

————

这是用于抓取网页内容的方法。

$URI 参数是被抓取网页的 URL 地址。

获取的结果存储在 $this->results 中。

如果你正在抓取一个帧,史努比会跟踪每一帧并将其存储在一个数组中,然后将其存储在 $this->results 中。

fetchtext($URI)

—————

该方法与fetch()类似,唯一不同的是该方法会去除HTML标签等无关数据,只返回网页中的文本内容。

fetchform($URI)

—————

该方法与fetch()类似,唯一不同的是该方法会去除HTML标签等无关数据,只返回网页中的表单内容(form)。

fetchlinks($URI)

—————-

该方法与fetch()类似,唯一不同的是,该方法会去除HTML标签等无关数据,只返回网页中的链接。

默认情况下,相对链接会自动补全并转换成完整的网址。

提交($URI,$formvars)

———————-

此方法向$URL 指定的链接地址发送确认表单。 $formvars 是一个存储表单参数的数组。

提交文本($URI,$formvars)

——————————

该方法与submit()类似,唯一不同的是,该方法会去除HTML标签等无关数据,登录后只返回网页中的文本内容。

提交链接($URI)

—————-

该方法与submit()类似,唯一不同的是,该方法会去除HTML标签等无关数据,只返回网页中的链接。

默认情况下,相对链接会自动补全并转换成完整的网址。

类属性:(括号内为默认值)

$host 连接的主机

$port 连接的端口

$proxy_host 使用的代理主机,如果有的话

$proxy_port 使用的代理主机端口,如果有的话

$agent 用户代理伪装(史努比 v0.1)

$referer 传入信息,如果有的话

$cookies cookies,如果有的话

$rawheaders 其他头信息,如果有的话

$maxredirs 最大重定向次数,0=不允许 (5)

$offsiteok 是否允许异地重定向。 (真)

$expandlinks 是否完成所有链接以完成地址(真实)

$user 认证用户名,如果有的话

$pass 认证用户名,如果有的话