php如何抓取网页数据

php如何抓取网页数据(php如何抓取网页数据?抓取了一大堆(图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 55 次浏览 • 2022-04-11 16:05

php如何抓取网页数据?爬虫抓取了一大堆网页,发现里面都是些乱七八糟的东西,怎么将它们提取出来有价值的信息?如何规划这样的框架结构,更好的利用爬虫数据?如何将数据直接拿去商城对比,让商家更便捷的发布商品?能不能拿这样的东西来联合朋友挣钱?网上已经有大量这样的问题。社区论坛无非是分享个人所掌握的知识,和人人都可以参与进来比起来,这些问题更像是在操作上的问题。

而linux工具链上就如同读者发现了某个观点,但能否用linux去让你找到信息和找到合适的解决方案,这就是计算机领域的问题。php解决这种问题最大的利器就是php解释器,可以用requests库将request封装成request对象,往返传递这个request对象所包含的信息就可以了。甚至可以用gzip压缩、bzip2压缩、webp等,但这些依然无法解决各种乱七八糟问题的问题。

其实,我们只要对request进行封装,每次请求返回的都是一个简单的request对象,这样数据格式可控性就高了,都可以用php很轻松的存入数据库,还可以按照操作系统对数据存取进行相应优化。常见封装方式。fastcgi封装方式。bjaffi封装方式。把请求,页面元素等封装成php字节码,php解释这种字节码可以提高效率。

python解释器封装。这个很重要。直接组合mysql、fastcgi、python字节码等,是提高开发效率的不二选择。coronaphp解释器封装方式。以上只适用于php开发者,如果你将web/java开发者用起来不行,corona是个不错的选择。node.jsphp解释器封装。node.js使用命令php_modules_manager.phpbydefault来把php文件变成php_client运行nodejs。

以上四种方式,是我遇到的大部分php开发者觉得比较好的解决方案。关于linux开发环境的具体搭建,我们有必要先了解一下linux的一些常见问题。linux环境搭建-linux文章-云栖社区-阿里云网站搭建常见问题:环境搭建的四个方式1.如果网络上找不到对应的文章,自己动手可能会有些问题。2.在linux上搭建,有些是要用rpm包,有些不需要用。

3.有了相关知识之后,安装,编译,测试环境,比自己来要快的多。4.自己开发环境没有提供完善的安装包,用centos或者ubuntu的话,建议重装一下比较好。linux环境搭建四大坑1.很多开发环境都需要相应的一个可执行的目录,如果linux环境一开始没有搭建好,还可能会出现部分目录没有路径引起不能启动,所以一定要做好日常查看的工作。2.网络方面要看好文章再搭建,一开始接触和开发是一样的,这种问题,开始一开始都是很难。 查看全部

php如何抓取网页数据(php如何抓取网页数据?抓取了一大堆(图))

php如何抓取网页数据?爬虫抓取了一大堆网页,发现里面都是些乱七八糟的东西,怎么将它们提取出来有价值的信息?如何规划这样的框架结构,更好的利用爬虫数据?如何将数据直接拿去商城对比,让商家更便捷的发布商品?能不能拿这样的东西来联合朋友挣钱?网上已经有大量这样的问题。社区论坛无非是分享个人所掌握的知识,和人人都可以参与进来比起来,这些问题更像是在操作上的问题。

而linux工具链上就如同读者发现了某个观点,但能否用linux去让你找到信息和找到合适的解决方案,这就是计算机领域的问题。php解决这种问题最大的利器就是php解释器,可以用requests库将request封装成request对象,往返传递这个request对象所包含的信息就可以了。甚至可以用gzip压缩、bzip2压缩、webp等,但这些依然无法解决各种乱七八糟问题的问题。

其实,我们只要对request进行封装,每次请求返回的都是一个简单的request对象,这样数据格式可控性就高了,都可以用php很轻松的存入数据库,还可以按照操作系统对数据存取进行相应优化。常见封装方式。fastcgi封装方式。bjaffi封装方式。把请求,页面元素等封装成php字节码,php解释这种字节码可以提高效率。

python解释器封装。这个很重要。直接组合mysql、fastcgi、python字节码等,是提高开发效率的不二选择。coronaphp解释器封装方式。以上只适用于php开发者,如果你将web/java开发者用起来不行,corona是个不错的选择。node.jsphp解释器封装。node.js使用命令php_modules_manager.phpbydefault来把php文件变成php_client运行nodejs。

以上四种方式,是我遇到的大部分php开发者觉得比较好的解决方案。关于linux开发环境的具体搭建,我们有必要先了解一下linux的一些常见问题。linux环境搭建-linux文章-云栖社区-阿里云网站搭建常见问题:环境搭建的四个方式1.如果网络上找不到对应的文章,自己动手可能会有些问题。2.在linux上搭建,有些是要用rpm包,有些不需要用。

3.有了相关知识之后,安装,编译,测试环境,比自己来要快的多。4.自己开发环境没有提供完善的安装包,用centos或者ubuntu的话,建议重装一下比较好。linux环境搭建四大坑1.很多开发环境都需要相应的一个可执行的目录,如果linux环境一开始没有搭建好,还可能会出现部分目录没有路径引起不能启动,所以一定要做好日常查看的工作。2.网络方面要看好文章再搭建,一开始接触和开发是一样的,这种问题,开始一开始都是很难。

php如何抓取网页数据(数据科学越来越怎么抓网页数据(一)_Python学习)

网站优化 • 优采云 发表了文章 • 0 个评论 • 62 次浏览 • 2022-03-29 06:02

2021-06-13

前言:

数据科学越来越流行,网页是一个巨大的数据来源。最近有很多人问如何抓取网页数据。据我所知,常见的编程语言(C++、java、python)都可以实现网页数据抓取,甚至很多统计/计算语言(R、Matlab)都可以实现和网站交互的包。试过用java、python、R爬取网页,感觉语法不一样,但逻辑是一样的。我将使用python来谈谈网络抓取的概念。具体内容需要看说明书或者google别人的博客。水平有限,有错误或者有更好的方法,欢迎讨论。. 更多信息

第 1 步:熟悉 Python 的基本语法

如果您已经熟悉 Python,请跳到第 2 步。

Python 是一种相对容易上手的编程语言,如何上手取决于编程基础。

(1)如果有一定的编程基础,建议看google的python类,链接——google 1point3acres

这是一个为期两天的短期培训课程(当然是两天全天),大约七个视频,每个视频后面都有编程作业,每个作业可以在一个小时内完成。这是我学python的第二门课(第一门是codecademy的python,很久以前看的,很多内容记不住了),每次看视频+编程作业一个多小时天,六天完成。不错,用python写基本程序没有问题。

(2)如果你没有任何编程基础,我建议你在coursera上阅读莱斯大学的An Introduction to Interactive Programming in Python。我没有上过这门课程,但是coursetalk上的评论非常积极,并且也有同学在现场评论(点这里),课程链接:Udacity上的CS101也是不错的选择,现场也有相关的讨论帖(点这里),而这门课叫做build a search engine,并且会专门讲一些网络相关的话题模块,其他的学习资源还有code school和codecademy,这些资源也挺不错的,但是编程量太少了,初学者应该系统的跟着课,多练习,打下扎实的基础基础。

当然,每个人的喜好不一样,我推荐的不一定适合你。你可以先看看这个帖子【长期红利帖】介绍别人在你上过的公开课上说了什么,或者看课程点评,然后再决定。

第二步:学习如何与网站建立链接并获取网页数据。

要编写与 网站 交互的脚本,您必须熟悉与 python 和网页相关的几个模块(urllib、urllib2、httplib)之一。你只需要知道一个,其他的都差不多。这三个是python提供的与网页交互的基础模块,还有其他的,比如:mechanize和scrapy,我没用过,可能性能更好,欢迎补充。对于基本的网页抓取,前三个模块就足够了。

以下代码演示了如何使用 urllib2 与 google Academic 交互获取网页信息。

# 导入模块 urllib2

import urllib2

# 随便查询一篇文章,比如On random graph。对每一个查询google

# scholar都有一个url,这个url形成的规则是要自己分析的。

query = 'On+random+graph'

url = 'http://scholar.google.com/scholar?hl=en&q=' + query + '&btnG=&as_sdt=1%2C5&as_sdtp='

# 设置头文件。抓取有些的网页不需要专门设置头文件,但是这里如果不设置的话,. 鐗涗汉浜戦泦,涓€浜╀笁鍒嗗湴

# google会认为是机器人不允许访问。另外访问有些网站还有设置Cookie,这个会相对复杂一些,

# 这里暂时不提。关于怎么知道头文件该怎么写,一些插件可以看到你用的浏览器和网站交互的

# 头文件(这种工具很多浏览器是自带的),我用的是firefox的firebug插件。.鏈枃鍘熷垱鑷�1point3acres璁哄潧

header = {'Host': 'scholar.google.com',

'User-Agent': 'Mozilla/5.0 (Windows NT 6.1; rv:26.0) Gecko/20100101 Firefox/26.0',

'Accept': 'text/html,application/xhtml+xml,application/xml;q=0.9,*/*;q=0.8',

'Accept-Encoding': 'gzip, deflate',

'Connection': 'keep-alive'}

# 建立连接请求,这时google的服务器返回页面信息给con这个变量,con是一个对象

req = urllib2.Request(url, headers = header)

con = urllib2.urlopen( req )

# 对con这个对象调用read()方法,返回的是html页面,也就是有html标签的纯文本

doc = con.read()

# 关闭连接。就像读完文件要关闭文件一样,如果不关闭有时可以、但有时会有问题,

# 所以作为一个守法的好公民,还是关闭连接好了。

con.close()

上面的代码将google Academic上查询On Random Graph的结果返回给doc变量,和打开google Academic搜索On Random Graph然后在网页上右键保存是一样的。

步骤三、解析网页

以上步骤获取网页的信息,但是收录html标签,需要去掉这些标签,然后从html文本中整理出有用的信息,

您需要解析此网页。

解析网页的方法:

(1) 正则表达式。正则表达式很有用。熟悉它们可以节省很多时间。有时你不需要写脚本或查询数据库来清理数据。你可以直接使用组合notepad++上的正则表达式,如何学习正则表达式推荐看:正则表达式30分钟入门教程,链接:. 更多信息

(2) BeautifulSoup 模块。BeautifulSoup 是一个非常强大的模块,可以将 html 文件解析成一个对象,也就是一棵树。我们都知道 html 文件是树状的,比如 body -> table -> tbody - > tr,对于节点tbody,tr的子节点很多,BeautifulSoup可以很方便的获取到具体的节点,对于单个节点也可以获取到它的兄弟节点,网上有很多相关说明,不详述这里。说一下,只是为了演示简单的代码:

(3) 以上两种方法结合使用。

# 导入BeautifulSoup模块和re模块,re是python中正则表达式的模块

import BeautifulSoup

import re

# 生成一个soup对象,doc就是步骤二中提到的

soup = BeautifulSoup.BeautifulSoup(doc)

# 抓取论文标题,作者,简短描述,引用次数,版本数,引用它的文章列表的超链接

# 这里还用了一些正则表达式,不熟悉的先无知它好了。至于'class' : 'gs_rt'中

# 'gs_rt'是怎么来的,这个是分析html文件肉眼看出来的。上面提到的firebug插件

# 让这个变的很简单,只要一点网页,就可以知道对应的html 标签的位置和属性,

# 相当好用。

paper_name = soup.html.body.find('h3', {'class' : 'gs_rt'}).text

paper_name = re.sub(r'\[.*\]', '', paper_name) # eliminate '[]' tags like '[PDF]'

paper_author = soup.html.body.find('div', {'class' : 'gs_a'}).text. from: 1point3acres.com/bbs

paper_desc = soup.html.body.find('div', {'class' : 'gs_rs'}).text

temp_str = soup.html.body.find('div', {'class' : 'gs_fl'}).text

temp_re = re.match(r'[A-Za-z\s]+(\d*)[A-Za-z\s]+(\d*)', temp_str)

citeTimes = temp_re.group(1)

versionNum = temp_re.group(2)

if citeTimes == '':

citeTimes = '0'

if versionNum == '':

versionNum = '0'

citedPaper_href = soup.html.body.find('div', {'class' : 'gs_fl'}).a.attrs[0][1]

这些是我正在为分析引文网络的项目编写的代码。对了,我从googlescholar那里抓取了论文和引文列表的信息,在我访问了大约1900次的时候就屏蔽了google,导致这个区的ip一时间无法登录googlescholar。

第 4 步:访问数据

数据终于被抓到了,但现在只存储在内存中,必须保存后才能使用。

(1) 将数据写入 txt 文件最简单的方法是在 Python 中使用以下代码:

# 打开文件webdata.txt,生成对象file,这个文件可以是不存在的,参数a表示往里面添加。

# 还有别的参数,比如'r'只能读但不能写入,'w'可以写入但是会删除原来的记录等等

file = open('webdata.txt','a')

line = paper_name + '#' + paper_author + '#' + paper_desc + '#' + citeTimes + '\n'

# 对象file的write方法将字符串line写入file中

file = file.write(line)

# 再一次的,做个随手关闭文件的好青年

file.close()

这样,从网页中抓取并解析出来的数据就存储在本地了,是不是很简单呢?

(2)当然也可以直接连接数据库而不是写入txt文件。python中的MySQLdb模块可以与MySQL数据库交互,将数据直接倒入数据库,与MySQL数据库的逻辑类似于与网站服务器建立链接的逻辑,如果你之前学过数据库,学习使用MySQLdb模块与数据库交互是很简单的;有一个系统学习的数据库介绍,w3school作为参考或手册使用。

Python能够链接数据库的前提是数据库是开放的。我用的是win7 + MySQL5.5,数据库是本地的。

%可以用cmd开启数据库,启动命令是:

net start mysql55

%关闭命令是:

net stop mysql55

使用 MySQLdb 模块的代码示例:

# 导入 MySQLdb模块

import MySQLdb

# 和服务器建立链接,host是服务器ip,我的MySQL数据库搭建在本机,默认的是127.0.0.1,

# 用户、密码、数据库名称对应着照输就行了,默认的端口号是3306,charset是编码方式,

# 默认的是utf8(也有可能是gbk,看安装的版本)。. visit 1point3acres.com for more.

conn = MySQLdb.connect(host='127.0.0.1', user='root', passwd='yourPassword', db='dbname', port=3306, charset='utf8'). 鍥磋鎴戜滑@1point 3 acres

# 建立cursor

cur = conn.cursor()# 通过对象cur的execute()方法执行SQL语句

cur.execute("select * from citeRelation where paperName = 'On Random Graph'")

# fetchall()方法获得查询结果,返回的是一个list,可以直接这样查询:list[i][j],

# i表示查询结果中的第i+1条record,j表示这条记录的第j+1个attribute(别忘了python从0开始计数)

list = cur.fetchall()

# 也可以进行delete,drop,insert,update等操作,比如

sql = "update studentCourseRecord set fail = 1 where studentID = '%s' and semesterID = '%s' and courseID = '%s'" %(studentID,course[0],course[1])

cur.execute(sql)

# 与查询不同的是,执行完delete,insert,update这些语句后必须执行下面的命令才能成功更新数据库

conn.commit()

# 一如既往的,用完了之后记得关闭cursor,然后关闭链接

cur.close()

conn.close()

这样就实现了Python与数据库的交互。除了 MySQL 数据库,python 的 PyGreSQL 模块可以支持 postgreSQL 数据库,原因类似。另外,如果你的网页收录中文,设置编码格式会很麻烦。您需要服务器、Python、数据库和数据库接口使用相同的编码格式,以避免出现乱码。如果出现中文乱码问题,请相信,你并不孤单!!去google吧,成千上万的人遇到过这个问题。

关于编码的问题,这里是我看到的一篇博文:

后记:

爬取网页数据的方法如上所述。爬取数据只是一小步。如何分析数据是大学的问题。欢迎讨论。

以上如有不明白之处,欢迎交流。

注意:

网站的大规模爬取会给网站的服务器带来很大的压力,尽量选择服务器比较轻松的时间(比如清晨)。网站很多,不要用三分之一英亩来测试。

Python 的 time 模块的 sleep() 方法可以暂停程序一段时间。比如time.sleep(1)这里程序运行的时候暂停1秒。及时暂停可以缓解服务器压力,保护自己的硬盘,只是为了睡很久,或者去健身房,结果出来了。

分类:

技术要点:

相关文章: 查看全部

php如何抓取网页数据(数据科学越来越怎么抓网页数据(一)_Python学习)

2021-06-13

前言:

数据科学越来越流行,网页是一个巨大的数据来源。最近有很多人问如何抓取网页数据。据我所知,常见的编程语言(C++、java、python)都可以实现网页数据抓取,甚至很多统计/计算语言(R、Matlab)都可以实现和网站交互的包。试过用java、python、R爬取网页,感觉语法不一样,但逻辑是一样的。我将使用python来谈谈网络抓取的概念。具体内容需要看说明书或者google别人的博客。水平有限,有错误或者有更好的方法,欢迎讨论。. 更多信息

第 1 步:熟悉 Python 的基本语法

如果您已经熟悉 Python,请跳到第 2 步。

Python 是一种相对容易上手的编程语言,如何上手取决于编程基础。

(1)如果有一定的编程基础,建议看google的python类,链接——google 1point3acres

这是一个为期两天的短期培训课程(当然是两天全天),大约七个视频,每个视频后面都有编程作业,每个作业可以在一个小时内完成。这是我学python的第二门课(第一门是codecademy的python,很久以前看的,很多内容记不住了),每次看视频+编程作业一个多小时天,六天完成。不错,用python写基本程序没有问题。

(2)如果你没有任何编程基础,我建议你在coursera上阅读莱斯大学的An Introduction to Interactive Programming in Python。我没有上过这门课程,但是coursetalk上的评论非常积极,并且也有同学在现场评论(点这里),课程链接:Udacity上的CS101也是不错的选择,现场也有相关的讨论帖(点这里),而这门课叫做build a search engine,并且会专门讲一些网络相关的话题模块,其他的学习资源还有code school和codecademy,这些资源也挺不错的,但是编程量太少了,初学者应该系统的跟着课,多练习,打下扎实的基础基础。

当然,每个人的喜好不一样,我推荐的不一定适合你。你可以先看看这个帖子【长期红利帖】介绍别人在你上过的公开课上说了什么,或者看课程点评,然后再决定。

第二步:学习如何与网站建立链接并获取网页数据。

要编写与 网站 交互的脚本,您必须熟悉与 python 和网页相关的几个模块(urllib、urllib2、httplib)之一。你只需要知道一个,其他的都差不多。这三个是python提供的与网页交互的基础模块,还有其他的,比如:mechanize和scrapy,我没用过,可能性能更好,欢迎补充。对于基本的网页抓取,前三个模块就足够了。

以下代码演示了如何使用 urllib2 与 google Academic 交互获取网页信息。

# 导入模块 urllib2

import urllib2

# 随便查询一篇文章,比如On random graph。对每一个查询google

# scholar都有一个url,这个url形成的规则是要自己分析的。

query = 'On+random+graph'

url = 'http://scholar.google.com/scholar?hl=en&q=' + query + '&btnG=&as_sdt=1%2C5&as_sdtp='

# 设置头文件。抓取有些的网页不需要专门设置头文件,但是这里如果不设置的话,. 鐗涗汉浜戦泦,涓€浜╀笁鍒嗗湴

# google会认为是机器人不允许访问。另外访问有些网站还有设置Cookie,这个会相对复杂一些,

# 这里暂时不提。关于怎么知道头文件该怎么写,一些插件可以看到你用的浏览器和网站交互的

# 头文件(这种工具很多浏览器是自带的),我用的是firefox的firebug插件。.鏈枃鍘熷垱鑷�1point3acres璁哄潧

header = {'Host': 'scholar.google.com',

'User-Agent': 'Mozilla/5.0 (Windows NT 6.1; rv:26.0) Gecko/20100101 Firefox/26.0',

'Accept': 'text/html,application/xhtml+xml,application/xml;q=0.9,*/*;q=0.8',

'Accept-Encoding': 'gzip, deflate',

'Connection': 'keep-alive'}

# 建立连接请求,这时google的服务器返回页面信息给con这个变量,con是一个对象

req = urllib2.Request(url, headers = header)

con = urllib2.urlopen( req )

# 对con这个对象调用read()方法,返回的是html页面,也就是有html标签的纯文本

doc = con.read()

# 关闭连接。就像读完文件要关闭文件一样,如果不关闭有时可以、但有时会有问题,

# 所以作为一个守法的好公民,还是关闭连接好了。

con.close()

上面的代码将google Academic上查询On Random Graph的结果返回给doc变量,和打开google Academic搜索On Random Graph然后在网页上右键保存是一样的。

步骤三、解析网页

以上步骤获取网页的信息,但是收录html标签,需要去掉这些标签,然后从html文本中整理出有用的信息,

您需要解析此网页。

解析网页的方法:

(1) 正则表达式。正则表达式很有用。熟悉它们可以节省很多时间。有时你不需要写脚本或查询数据库来清理数据。你可以直接使用组合notepad++上的正则表达式,如何学习正则表达式推荐看:正则表达式30分钟入门教程,链接:. 更多信息

(2) BeautifulSoup 模块。BeautifulSoup 是一个非常强大的模块,可以将 html 文件解析成一个对象,也就是一棵树。我们都知道 html 文件是树状的,比如 body -> table -> tbody - > tr,对于节点tbody,tr的子节点很多,BeautifulSoup可以很方便的获取到具体的节点,对于单个节点也可以获取到它的兄弟节点,网上有很多相关说明,不详述这里。说一下,只是为了演示简单的代码:

(3) 以上两种方法结合使用。

# 导入BeautifulSoup模块和re模块,re是python中正则表达式的模块

import BeautifulSoup

import re

# 生成一个soup对象,doc就是步骤二中提到的

soup = BeautifulSoup.BeautifulSoup(doc)

# 抓取论文标题,作者,简短描述,引用次数,版本数,引用它的文章列表的超链接

# 这里还用了一些正则表达式,不熟悉的先无知它好了。至于'class' : 'gs_rt'中

# 'gs_rt'是怎么来的,这个是分析html文件肉眼看出来的。上面提到的firebug插件

# 让这个变的很简单,只要一点网页,就可以知道对应的html 标签的位置和属性,

# 相当好用。

paper_name = soup.html.body.find('h3', {'class' : 'gs_rt'}).text

paper_name = re.sub(r'\[.*\]', '', paper_name) # eliminate '[]' tags like '[PDF]'

paper_author = soup.html.body.find('div', {'class' : 'gs_a'}).text. from: 1point3acres.com/bbs

paper_desc = soup.html.body.find('div', {'class' : 'gs_rs'}).text

temp_str = soup.html.body.find('div', {'class' : 'gs_fl'}).text

temp_re = re.match(r'[A-Za-z\s]+(\d*)[A-Za-z\s]+(\d*)', temp_str)

citeTimes = temp_re.group(1)

versionNum = temp_re.group(2)

if citeTimes == '':

citeTimes = '0'

if versionNum == '':

versionNum = '0'

citedPaper_href = soup.html.body.find('div', {'class' : 'gs_fl'}).a.attrs[0][1]

这些是我正在为分析引文网络的项目编写的代码。对了,我从googlescholar那里抓取了论文和引文列表的信息,在我访问了大约1900次的时候就屏蔽了google,导致这个区的ip一时间无法登录googlescholar。

第 4 步:访问数据

数据终于被抓到了,但现在只存储在内存中,必须保存后才能使用。

(1) 将数据写入 txt 文件最简单的方法是在 Python 中使用以下代码:

# 打开文件webdata.txt,生成对象file,这个文件可以是不存在的,参数a表示往里面添加。

# 还有别的参数,比如'r'只能读但不能写入,'w'可以写入但是会删除原来的记录等等

file = open('webdata.txt','a')

line = paper_name + '#' + paper_author + '#' + paper_desc + '#' + citeTimes + '\n'

# 对象file的write方法将字符串line写入file中

file = file.write(line)

# 再一次的,做个随手关闭文件的好青年

file.close()

这样,从网页中抓取并解析出来的数据就存储在本地了,是不是很简单呢?

(2)当然也可以直接连接数据库而不是写入txt文件。python中的MySQLdb模块可以与MySQL数据库交互,将数据直接倒入数据库,与MySQL数据库的逻辑类似于与网站服务器建立链接的逻辑,如果你之前学过数据库,学习使用MySQLdb模块与数据库交互是很简单的;有一个系统学习的数据库介绍,w3school作为参考或手册使用。

Python能够链接数据库的前提是数据库是开放的。我用的是win7 + MySQL5.5,数据库是本地的。

%可以用cmd开启数据库,启动命令是:

net start mysql55

%关闭命令是:

net stop mysql55

使用 MySQLdb 模块的代码示例:

# 导入 MySQLdb模块

import MySQLdb

# 和服务器建立链接,host是服务器ip,我的MySQL数据库搭建在本机,默认的是127.0.0.1,

# 用户、密码、数据库名称对应着照输就行了,默认的端口号是3306,charset是编码方式,

# 默认的是utf8(也有可能是gbk,看安装的版本)。. visit 1point3acres.com for more.

conn = MySQLdb.connect(host='127.0.0.1', user='root', passwd='yourPassword', db='dbname', port=3306, charset='utf8'). 鍥磋鎴戜滑@1point 3 acres

# 建立cursor

cur = conn.cursor()# 通过对象cur的execute()方法执行SQL语句

cur.execute("select * from citeRelation where paperName = 'On Random Graph'")

# fetchall()方法获得查询结果,返回的是一个list,可以直接这样查询:list[i][j],

# i表示查询结果中的第i+1条record,j表示这条记录的第j+1个attribute(别忘了python从0开始计数)

list = cur.fetchall()

# 也可以进行delete,drop,insert,update等操作,比如

sql = "update studentCourseRecord set fail = 1 where studentID = '%s' and semesterID = '%s' and courseID = '%s'" %(studentID,course[0],course[1])

cur.execute(sql)

# 与查询不同的是,执行完delete,insert,update这些语句后必须执行下面的命令才能成功更新数据库

conn.commit()

# 一如既往的,用完了之后记得关闭cursor,然后关闭链接

cur.close()

conn.close()

这样就实现了Python与数据库的交互。除了 MySQL 数据库,python 的 PyGreSQL 模块可以支持 postgreSQL 数据库,原因类似。另外,如果你的网页收录中文,设置编码格式会很麻烦。您需要服务器、Python、数据库和数据库接口使用相同的编码格式,以避免出现乱码。如果出现中文乱码问题,请相信,你并不孤单!!去google吧,成千上万的人遇到过这个问题。

关于编码的问题,这里是我看到的一篇博文:

后记:

爬取网页数据的方法如上所述。爬取数据只是一小步。如何分析数据是大学的问题。欢迎讨论。

以上如有不明白之处,欢迎交流。

注意:

网站的大规模爬取会给网站的服务器带来很大的压力,尽量选择服务器比较轻松的时间(比如清晨)。网站很多,不要用三分之一英亩来测试。

Python 的 time 模块的 sleep() 方法可以暂停程序一段时间。比如time.sleep(1)这里程序运行的时候暂停1秒。及时暂停可以缓解服务器压力,保护自己的硬盘,只是为了睡很久,或者去健身房,结果出来了。

分类:

技术要点:

相关文章:

php如何抓取网页数据(php如何抓取网页数据(php框架-1.4.2))

网站优化 • 优采云 发表了文章 • 0 个评论 • 46 次浏览 • 2022-03-28 17:03

php如何抓取网页数据,今天教给大家一个php抓取的方法。那怎么抓取网页数据呢,比如我们要抓取一个网站的网页数据,用框架来实现就可以了。我们看一下网页爬取的结果就知道了(php框架-1.4.2)大家看一下看起来很简单吧,跟我一起来实现抓取下面我们看一下步骤。首先我们需要先下载一下我们今天用到的框架,我用的是swoole或者javaphp,大家看到我分享的链接还是直接到框架官网下载即可。

swoolemysql-jdbc请自行百度。然后我们需要将爬取的网页数据写到数据库,用于后续处理,把下载下来的网页数据写入mysql数据库,大家看一下(链接:链接:-go0jyo28tikihbjrrd7jgg9&utm_source=sh1.xtgzhihukh1xfkhw_d.html&utm_medium=social)图一图一里面我发现很明显我们需要爬取页面的文字信息,因为我们要先获取我们爬取的网页的地址,然后才能进行抓取网页数据。

大家可以看到文字信息是我们需要抓取的数据,我们还要获取到是页面上的url地址才能爬取这个网页数据。所以我们需要写到我们的java爬虫程序当中去,我们看一下(链接:链接::n8bc)上面三个图片当中我们发现我们是直接将网页代码爬取下来我们就能找到它的url数据了,我们现在来写爬虫程序代码:我们先去抓取链接,我们需要抓取网页的链接,下面我们来抓取一下:/var/lib/sitemap/star-version.js我们发现我们是需要爬取到页面的地址我们才能爬取到数据,我们接着看:/var/lib/sitemap/engine/path.js我们发现这个是我们定义爬取的路径,接着我们对象我们直接path.join去抓取路径。

大家如果你想知道网页编码为什么为utf-8,hh-my-god,我发现一些网站它爬取的时候是python解析的,一些是php解析的。或者是perl/c或者是php,这就要写到爬虫程序代码中去。然后我们发现我们是需要获取到这个url的。我们通过抓取之后的网页就能够获取到它的url,我们还需要取出这个url上面的参数。

大家看一下(链接:www.**.com/pdf/s5lz1tzn2yawzzw)我们来看一下它的url参数:我们需要从dt开始算起,然后接着分8小步来爬取到数据:img_path/v1/c2h2zf9a0a9yiwnzjpwqoauvcjwjstmym2ltouvlcgs0/v2/proc2gzbjd0uw3neu0qshtm3r0sgj5jrcg7uxg7y0iigqkahnhjcorcgzhemdoc1esfsgwew/v2/c2h2zf9a0a9yiwnzjpwqoauvcjwjstmym2ltou。 查看全部

php如何抓取网页数据(php如何抓取网页数据(php框架-1.4.2))

php如何抓取网页数据,今天教给大家一个php抓取的方法。那怎么抓取网页数据呢,比如我们要抓取一个网站的网页数据,用框架来实现就可以了。我们看一下网页爬取的结果就知道了(php框架-1.4.2)大家看一下看起来很简单吧,跟我一起来实现抓取下面我们看一下步骤。首先我们需要先下载一下我们今天用到的框架,我用的是swoole或者javaphp,大家看到我分享的链接还是直接到框架官网下载即可。

swoolemysql-jdbc请自行百度。然后我们需要将爬取的网页数据写到数据库,用于后续处理,把下载下来的网页数据写入mysql数据库,大家看一下(链接:链接:-go0jyo28tikihbjrrd7jgg9&utm_source=sh1.xtgzhihukh1xfkhw_d.html&utm_medium=social)图一图一里面我发现很明显我们需要爬取页面的文字信息,因为我们要先获取我们爬取的网页的地址,然后才能进行抓取网页数据。

大家可以看到文字信息是我们需要抓取的数据,我们还要获取到是页面上的url地址才能爬取这个网页数据。所以我们需要写到我们的java爬虫程序当中去,我们看一下(链接:链接::n8bc)上面三个图片当中我们发现我们是直接将网页代码爬取下来我们就能找到它的url数据了,我们现在来写爬虫程序代码:我们先去抓取链接,我们需要抓取网页的链接,下面我们来抓取一下:/var/lib/sitemap/star-version.js我们发现我们是需要爬取到页面的地址我们才能爬取到数据,我们接着看:/var/lib/sitemap/engine/path.js我们发现这个是我们定义爬取的路径,接着我们对象我们直接path.join去抓取路径。

大家如果你想知道网页编码为什么为utf-8,hh-my-god,我发现一些网站它爬取的时候是python解析的,一些是php解析的。或者是perl/c或者是php,这就要写到爬虫程序代码中去。然后我们发现我们是需要获取到这个url的。我们通过抓取之后的网页就能够获取到它的url,我们还需要取出这个url上面的参数。

大家看一下(链接:www.**.com/pdf/s5lz1tzn2yawzzw)我们来看一下它的url参数:我们需要从dt开始算起,然后接着分8小步来爬取到数据:img_path/v1/c2h2zf9a0a9yiwnzjpwqoauvcjwjstmym2ltouvlcgs0/v2/proc2gzbjd0uw3neu0qshtm3r0sgj5jrcg7uxg7y0iigqkahnhjcorcgzhemdoc1esfsgwew/v2/c2h2zf9a0a9yiwnzjpwqoauvcjwjstmym2ltou。

php如何抓取网页数据(php如何抓取网页数据,对网页的抓取有很多方法)

网站优化 • 优采云 发表了文章 • 0 个评论 • 48 次浏览 • 2022-03-16 23:05

php如何抓取网页数据,对网页的抓取有很多方法,如:自己抓取、爬虫抓取、全局抓取等,对于php全局抓取有兴趣的同学可以看下这里。1.fiddler设置过滤条件通过下面代码手动设置或者导入fiddler框架,获取url//通过fiddlerfiddler.init('proxy','user','proxy',null);request对象proxy对象是什么proxy.open_proxy('get',"'/proxy/','get',"/');//设置tcp方法request对象tcp/ip()get方法send方法return当然是返回get类型的了,但是如果是get返回的是一个post参数array类型的数组或者无法获取post参数的参数,就可以用来当proxies参数,返回一个inode来当成fiddler的参数。

2.在路由表中设置过滤条件路由设置策略来干哪些事情呢?比如:url如果在/:420或者更高一层,在/:421是get,在/:422是post,post中owner可以null,owner设置为db,这样就可以正常调用api,但是这样无法自定义或者阻止/:421:/,原因是post参数名中owner指定不是db,在设置时会打印非空的值。

但是也可以根据规则来做非法页面过滤。//获取url中非法参数arrayarray=filter.get_array('request_params',params);array=array(array.push('user','request_content'),'none');filter函数传入三个参数,第一个是一个数组传入多个参数,第二个是函数,对函数的参数一个一个从右向左遍历找,第三个传入的参数是一个非空的数组,array()函数返回一个三值数组。

filter中params传入三个参数params,通过对方法参数有区别设置exception对象(request对象,非法参数对象等)和一个数组作为空数组作为参数传递,通过user对象参数有区别设置exception对象,和其中所包含的字符串作为参数,不传的话默认传递的是空数组作为参数,request对象中id参数必须有一个,params对象中的所有参数必须有一个字符串或者数组传递到,如果这些参数需要读取某个参数需要返回(id,name),然后array()函数才能够获取到参数filter()函数params的初始值和下面代码一样,下面传递数组的是值。

//获取url中的非法值array[]array=filter.get_array('request_params',params);filter(request,array[],stringid){if(array.isnull(id)){params.value=array[id];}else{returnparams.value;}}3.执行主要抓取任务不同的抓取任务可以看成不同类型的变量:1)。 查看全部

php如何抓取网页数据(php如何抓取网页数据,对网页的抓取有很多方法)

php如何抓取网页数据,对网页的抓取有很多方法,如:自己抓取、爬虫抓取、全局抓取等,对于php全局抓取有兴趣的同学可以看下这里。1.fiddler设置过滤条件通过下面代码手动设置或者导入fiddler框架,获取url//通过fiddlerfiddler.init('proxy','user','proxy',null);request对象proxy对象是什么proxy.open_proxy('get',"'/proxy/','get',"/');//设置tcp方法request对象tcp/ip()get方法send方法return当然是返回get类型的了,但是如果是get返回的是一个post参数array类型的数组或者无法获取post参数的参数,就可以用来当proxies参数,返回一个inode来当成fiddler的参数。

2.在路由表中设置过滤条件路由设置策略来干哪些事情呢?比如:url如果在/:420或者更高一层,在/:421是get,在/:422是post,post中owner可以null,owner设置为db,这样就可以正常调用api,但是这样无法自定义或者阻止/:421:/,原因是post参数名中owner指定不是db,在设置时会打印非空的值。

但是也可以根据规则来做非法页面过滤。//获取url中非法参数arrayarray=filter.get_array('request_params',params);array=array(array.push('user','request_content'),'none');filter函数传入三个参数,第一个是一个数组传入多个参数,第二个是函数,对函数的参数一个一个从右向左遍历找,第三个传入的参数是一个非空的数组,array()函数返回一个三值数组。

filter中params传入三个参数params,通过对方法参数有区别设置exception对象(request对象,非法参数对象等)和一个数组作为空数组作为参数传递,通过user对象参数有区别设置exception对象,和其中所包含的字符串作为参数,不传的话默认传递的是空数组作为参数,request对象中id参数必须有一个,params对象中的所有参数必须有一个字符串或者数组传递到,如果这些参数需要读取某个参数需要返回(id,name),然后array()函数才能够获取到参数filter()函数params的初始值和下面代码一样,下面传递数组的是值。

//获取url中的非法值array[]array=filter.get_array('request_params',params);filter(request,array[],stringid){if(array.isnull(id)){params.value=array[id];}else{returnparams.value;}}3.执行主要抓取任务不同的抓取任务可以看成不同类型的变量:1)。

php如何抓取网页数据(做过j2ee或android开发的童鞋,应该或多或少都使用过Apeache的HttpClient类库)

网站优化 • 优采云 发表了文章 • 0 个评论 • 52 次浏览 • 2022-03-08 03:01

如果你做过童鞋的j2ee或者android开发,应该多多少少用过Apeache的HttpClient类库。这个类库为我们提供了非常强大的服务端Http请求操作。在开发中使用非常方便。

最近在php的开发中,也需要在服务端发送http请求,然后再处理回客户端。

我google了一下,发现php中有这样一个类库,名字叫httpclient。我很兴奋。去了官网,发现已经很多年没有更新了,功能好像也有限,很是失望。然后我找到了另一个类库,Snoopy。我对这个类库了解不多,但是网上的反响还不错,所以我决定用它。它的 API 使用与 Apache 的 HttpClient 有很大的不同,但仍然非常好用。并且提供了很多特殊用途的方法,比如只能抓取页面中的form表单,或者所有的链接等等。

include 'Snoopy.class.php';

$snoopy = new Snoopy();

$snoopy->fetch("http://www.baidu.com");

echo $snoopy->results;

以上几行代码就可以轻松爬取百度的页面。

当然,当需要发送post表单时,可以使用submit方法提交数据。

同时,他还传递了cookies的请求头、对应头以及相关操作函数,功能非常强大。

include "Snoopy.class.php";

$snoopy = new Snoopy();

$snoopy->proxy_host = "http://www.baidu.cn";

$snoopy->proxy_port = "80";

$snoopy->agent = "(compatible; MSIE 4.01; MSN 2.5; AOL 4.0; Windows 98)";

$snoopy->referer = "http://www.4wei.cn";

$snoopy->cookies["SessionID"] = '238472834723489';

$snoopy->cookies["favoriteColor"] = "RED";

$snoopy->rawheaders["Pragma"] = "no-cache";

$snoopy->maxredirs = 2;

$snoopy->offsiteok = false;

$snoopy->expandlinks = false;

$snoopy->user = "joe";

$snoopy->pass = "bloe";

if($snoopy->fetchtext("http://www.baidu.cn")) {

echo "" . htmlspecialchars($snoopy->results) . "

\n";} else {echo "错误获取文档:" . $snoopy->error . "\n";}

更多操作方法可以去Snoopy的官方文档,或者直接查看源码。

此时,snoopy 只取回页面。如果您想从获取的页面中提取数据,那么它不会有太大帮助。这里又找到了一个php解析html的好工具:phpQuery,它提供了和jquery几乎一样的操作方法,并且提供了一些php的特性,熟悉jquery的童鞋,应该还是蛮好用的phpquery,连phpQuery的文档都没有已经需要了。。

使用Snoopy+PhpQuery可以轻松实现网页抓取和数据分析。这是非常有用的。我最近也需要这个,只找到了这两个不错的类库。事实证明,java可以做的事情有很多。php也可以做到。

有兴趣的同学也可以尝试用它们制作一个简单的网络爬虫。 查看全部

php如何抓取网页数据(做过j2ee或android开发的童鞋,应该或多或少都使用过Apeache的HttpClient类库)

如果你做过童鞋的j2ee或者android开发,应该多多少少用过Apeache的HttpClient类库。这个类库为我们提供了非常强大的服务端Http请求操作。在开发中使用非常方便。

最近在php的开发中,也需要在服务端发送http请求,然后再处理回客户端。

我google了一下,发现php中有这样一个类库,名字叫httpclient。我很兴奋。去了官网,发现已经很多年没有更新了,功能好像也有限,很是失望。然后我找到了另一个类库,Snoopy。我对这个类库了解不多,但是网上的反响还不错,所以我决定用它。它的 API 使用与 Apache 的 HttpClient 有很大的不同,但仍然非常好用。并且提供了很多特殊用途的方法,比如只能抓取页面中的form表单,或者所有的链接等等。

include 'Snoopy.class.php';

$snoopy = new Snoopy();

$snoopy->fetch("http://www.baidu.com";);

echo $snoopy->results;

以上几行代码就可以轻松爬取百度的页面。

当然,当需要发送post表单时,可以使用submit方法提交数据。

同时,他还传递了cookies的请求头、对应头以及相关操作函数,功能非常强大。

include "Snoopy.class.php";

$snoopy = new Snoopy();

$snoopy->proxy_host = "http://www.baidu.cn";

$snoopy->proxy_port = "80";

$snoopy->agent = "(compatible; MSIE 4.01; MSN 2.5; AOL 4.0; Windows 98)";

$snoopy->referer = "http://www.4wei.cn";

$snoopy->cookies["SessionID"] = '238472834723489';

$snoopy->cookies["favoriteColor"] = "RED";

$snoopy->rawheaders["Pragma"] = "no-cache";

$snoopy->maxredirs = 2;

$snoopy->offsiteok = false;

$snoopy->expandlinks = false;

$snoopy->user = "joe";

$snoopy->pass = "bloe";

if($snoopy->fetchtext("http://www.baidu.cn";)) {

echo "" . htmlspecialchars($snoopy->results) . "

\n";} else {echo "错误获取文档:" . $snoopy->error . "\n";}

更多操作方法可以去Snoopy的官方文档,或者直接查看源码。

此时,snoopy 只取回页面。如果您想从获取的页面中提取数据,那么它不会有太大帮助。这里又找到了一个php解析html的好工具:phpQuery,它提供了和jquery几乎一样的操作方法,并且提供了一些php的特性,熟悉jquery的童鞋,应该还是蛮好用的phpquery,连phpQuery的文档都没有已经需要了。。

使用Snoopy+PhpQuery可以轻松实现网页抓取和数据分析。这是非常有用的。我最近也需要这个,只找到了这两个不错的类库。事实证明,java可以做的事情有很多。php也可以做到。

有兴趣的同学也可以尝试用它们制作一个简单的网络爬虫。

php如何抓取网页数据( 入门注册API怎么用NewYorkTimesAPI来收集头条新闻?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 101 次浏览 • 2022-03-06 01:03

入门注册API怎么用NewYorkTimesAPI来收集头条新闻?)

使用纽约时报 API 抓取元数据

介绍

上周,我写了一篇关于抓取网络获取元数据的介绍,提到无法抓取纽约时报 网站。时报付费墙会阻止您采集基本元数据的尝试。但是有一种方法可以使用纽约时报 API。

最近我开始在 Yii 平台上建立一个社区站点,我将在以后的教程中发布。我想让添加与 网站 内容相关的链接变得容易。虽然人们很容易将 URL 粘贴到表单中,但同时提供标题和来源信息会变得很耗时。

因此,在今天的教程中,我将扩展我最近编写的抓取代码,以在添加 Times 链接时利用 New York Times API 来采集头条新闻。

请记住,我参与了下面的评论线程,所以让我知道您的想法!您也可以在 Twitter @lookahead_io 上与我联系。

开始注册 API 密钥

首先,让我们注册申请一个 API Key:

提交表格后,您将通过电子邮件收到您的密钥:

探索纽约时报 API

The Times 提供以下类别的 API:

很多。并且,在 Gallery 页面中,您可以单击任何主题以查看各个 API 类别文档:

Times 使用 LucyBot 来支持他们的 API 文档,并提供了一个有用的常见问题解答:

他们甚至向您展示了如何快速获取 API 使用限制(您需要插入密钥):

curl --head

https://api.nytimes.com/svc/bo ... ey%3D

2>/dev/null | grep -i "X-RateLimit"

X-RateLimit-Limit-day: 1000

X-RateLimit-Limit-second: 5

X-RateLimit-Remaining-day: 180

X-RateLimit-Remaining-second: 5

一开始我很难理解文档——它是基于参数的规范,而不是编程指南。但是,我将一些问题作为问题发布到了纽约时报 API GitHub 页面,它们得到了快速而有帮助的回答。

使用 文章 搜索

在今天的节目中,我将专注于使用《纽约时报》文章 搜索。基本上,我们将从上一个教程的扩展中创建一个链接表单:

当用户点击 Lookup 时,我们将通过 Link::grab($url) 发出 ajax 请求。这是jQuery:

$(document).on("click", '[id=lookup]', function(event) {

$.ajax({

url: $('#url_prefix').val()+'/link/grab',

data: {url: $('#url').val()},

success: function(data) {

$('#title').val(data);

return true;

}

});

});

这是控制器和模型方法:

// Controller call via AJAX Lookup request

public static function actionGrab($url) {

Yii::$app->response->format = Response::FORMAT_JSON;

return Link::grab($url);

}

...

// Link::grab() method

public static function grab($url) {

//clean up url for hostname

$source_url = parse_url($url);

$source_url = $source_url['host'];

$source_url=str_ireplace('www.','',$source_url);

$source_url = trim($source_url,' \\');

// use the NYT API when hostname == nytimes.com

if ($source_url=='nytimes.com') {

...

接下来,让我们使用我们的 API 密钥发出 文章 搜索请求:

$nytKey=Yii::$app->params['nytapi'];

$curl_dest = 'http://api.nytimes.com

/svc/search/v2/articlesearch.json?fl=headline&fq=web_url:%22'.

$url.'%22&api-key='.$nytKey;

$curl = curl_init();

curl_setopt($curl, CURLOPT_RETURNTRANSFER, true);

curl_setopt($curl, CURLOPT_URL,$curl_dest);

$result = json_decode(curl_exec($curl));

$title = $result->response->docs[0]->headline->main;

} else {

// not NYT, use the standard metatag scraper from last episode

...

}

}

return $title;

}

它很容易工作 - 这是由此产生的标题(顺便说一句,气候变化正在杀死北极熊,我们应该关心):

如果您想从 API 请求中获取更多详细信息,只需在 ?fl=headline 请求中添加其他参数,例如关键字和lead_paragraph:

Yii::$app->response->format = Response::FORMAT_JSON;

$nytKey=Yii::$app->params['nytapi'];

$curl_dest = 'http://api.nytimes.com/svc/search/v2/articlesearch.json?'.

'fl=headline,keywords,lead_paragraph&fq=web_url:%22'.$url.'%22&api-key='.$nytKey;

$curl = curl_init();

curl_setopt($curl, CURLOPT_RETURNTRANSFER, true);

curl_setopt($curl, CURLOPT_URL,$curl_dest);

$result = json_decode(curl_exec($curl));

var_dump($result);

结果如下:

也许我会在接下来的几集中编写一个 PHP 库来更好地解析 NYT API,但是这段代码将关键字和前导段落分开:

Yii::$app->response->format = Response::FORMAT_JSON;

$nytKey=Yii::$app->params['nytapi'];

$curl_dest = 'http://api.nytimes.com/svc/search/v2/articlesearch.json?'.

'fl=headline,keywords,lead_paragraph&fq=web_url:%22'.$url.'%22&api-key='.$nytKey;

$curl = curl_init();

curl_setopt($curl, CURLOPT_RETURNTRANSFER, true);

curl_setopt($curl, CURLOPT_URL,$curl_dest);

$result = json_decode(curl_exec($curl));

echo $result->response->docs[0]->headline->main.'<br />'.'<br />';

echo $result->response->docs[0]->lead_paragraph.'<br />'.'<br />';

foreach ($result->response->docs[0]->keywords as $k) {

echo $k->value.'

';

}

下面是它为这个 文章 显示的内容:

Polar Bears’ Path to Decline Runs Through Alaskan Village

The bears that come here are climate refugees, on land because

the sea ice they rely on for hunting seals is receding.

Polar Bears

Greenhouse Gas Emissions

Alaska

Global Warming

Endangered and Extinct Species

International Union for Conservation of Nature

National Snow and Ice Data Center

Polar Bears International

United States Geological Survey

希望这开始扩展您对如何使用这些 API 的想象。现在可能发生的事情非常令人兴奋。

当它结束时

New York Times API 非常有用,我很高兴看到他们将它提供给开发人员社区。通过 GitHub 获得如此快速的 API 支持也令人耳目一新——我只是没想到。请记住,它适用于非商业项目。如果您有一些赚钱的想法,请给他们发一封信,看看他们是否会与您合作。出版商渴望新的收入来源。

我希望您发现这些网络抓取片段很有帮助,并在您的项目中使用它们。如果你想看今天的节目,你可以在我的 网站 Active Together 上尝试一些网络抓取。

请在评论中分享任何想法和反馈。您也可以随时在 Twitter @lookahead_io 上直接与我联系。请务必查看我的讲师页面和其他关于使用 PHP 构建您的初创公司和使用 Yii2 编程的系列文章。

相关链接 查看全部

php如何抓取网页数据(

入门注册API怎么用NewYorkTimesAPI来收集头条新闻?)

使用纽约时报 API 抓取元数据

介绍

上周,我写了一篇关于抓取网络获取元数据的介绍,提到无法抓取纽约时报 网站。时报付费墙会阻止您采集基本元数据的尝试。但是有一种方法可以使用纽约时报 API。

最近我开始在 Yii 平台上建立一个社区站点,我将在以后的教程中发布。我想让添加与 网站 内容相关的链接变得容易。虽然人们很容易将 URL 粘贴到表单中,但同时提供标题和来源信息会变得很耗时。

因此,在今天的教程中,我将扩展我最近编写的抓取代码,以在添加 Times 链接时利用 New York Times API 来采集头条新闻。

请记住,我参与了下面的评论线程,所以让我知道您的想法!您也可以在 Twitter @lookahead_io 上与我联系。

开始注册 API 密钥

首先,让我们注册申请一个 API Key:

提交表格后,您将通过电子邮件收到您的密钥:

探索纽约时报 API

The Times 提供以下类别的 API:

很多。并且,在 Gallery 页面中,您可以单击任何主题以查看各个 API 类别文档:

Times 使用 LucyBot 来支持他们的 API 文档,并提供了一个有用的常见问题解答:

他们甚至向您展示了如何快速获取 API 使用限制(您需要插入密钥):

curl --head

https://api.nytimes.com/svc/bo ... ey%3D

2>/dev/null | grep -i "X-RateLimit"

X-RateLimit-Limit-day: 1000

X-RateLimit-Limit-second: 5

X-RateLimit-Remaining-day: 180

X-RateLimit-Remaining-second: 5

一开始我很难理解文档——它是基于参数的规范,而不是编程指南。但是,我将一些问题作为问题发布到了纽约时报 API GitHub 页面,它们得到了快速而有帮助的回答。

使用 文章 搜索

在今天的节目中,我将专注于使用《纽约时报》文章 搜索。基本上,我们将从上一个教程的扩展中创建一个链接表单:

当用户点击 Lookup 时,我们将通过 Link::grab($url) 发出 ajax 请求。这是jQuery:

$(document).on("click", '[id=lookup]', function(event) {

$.ajax({

url: $('#url_prefix').val()+'/link/grab',

data: {url: $('#url').val()},

success: function(data) {

$('#title').val(data);

return true;

}

});

});

这是控制器和模型方法:

// Controller call via AJAX Lookup request

public static function actionGrab($url) {

Yii::$app->response->format = Response::FORMAT_JSON;

return Link::grab($url);

}

...

// Link::grab() method

public static function grab($url) {

//clean up url for hostname

$source_url = parse_url($url);

$source_url = $source_url['host'];

$source_url=str_ireplace('www.','',$source_url);

$source_url = trim($source_url,' \\');

// use the NYT API when hostname == nytimes.com

if ($source_url=='nytimes.com') {

...

接下来,让我们使用我们的 API 密钥发出 文章 搜索请求:

$nytKey=Yii::$app->params['nytapi'];

$curl_dest = 'http://api.nytimes.com

/svc/search/v2/articlesearch.json?fl=headline&fq=web_url:%22'.

$url.'%22&api-key='.$nytKey;

$curl = curl_init();

curl_setopt($curl, CURLOPT_RETURNTRANSFER, true);

curl_setopt($curl, CURLOPT_URL,$curl_dest);

$result = json_decode(curl_exec($curl));

$title = $result->response->docs[0]->headline->main;

} else {

// not NYT, use the standard metatag scraper from last episode

...

}

}

return $title;

}

它很容易工作 - 这是由此产生的标题(顺便说一句,气候变化正在杀死北极熊,我们应该关心):

如果您想从 API 请求中获取更多详细信息,只需在 ?fl=headline 请求中添加其他参数,例如关键字和lead_paragraph:

Yii::$app->response->format = Response::FORMAT_JSON;

$nytKey=Yii::$app->params['nytapi'];

$curl_dest = 'http://api.nytimes.com/svc/search/v2/articlesearch.json?'.

'fl=headline,keywords,lead_paragraph&fq=web_url:%22'.$url.'%22&api-key='.$nytKey;

$curl = curl_init();

curl_setopt($curl, CURLOPT_RETURNTRANSFER, true);

curl_setopt($curl, CURLOPT_URL,$curl_dest);

$result = json_decode(curl_exec($curl));

var_dump($result);

结果如下:

也许我会在接下来的几集中编写一个 PHP 库来更好地解析 NYT API,但是这段代码将关键字和前导段落分开:

Yii::$app->response->format = Response::FORMAT_JSON;

$nytKey=Yii::$app->params['nytapi'];

$curl_dest = 'http://api.nytimes.com/svc/search/v2/articlesearch.json?'.

'fl=headline,keywords,lead_paragraph&fq=web_url:%22'.$url.'%22&api-key='.$nytKey;

$curl = curl_init();

curl_setopt($curl, CURLOPT_RETURNTRANSFER, true);

curl_setopt($curl, CURLOPT_URL,$curl_dest);

$result = json_decode(curl_exec($curl));

echo $result->response->docs[0]->headline->main.'<br />'.'<br />';

echo $result->response->docs[0]->lead_paragraph.'<br />'.'<br />';

foreach ($result->response->docs[0]->keywords as $k) {

echo $k->value.'

';

}

下面是它为这个 文章 显示的内容:

Polar Bears’ Path to Decline Runs Through Alaskan Village

The bears that come here are climate refugees, on land because

the sea ice they rely on for hunting seals is receding.

Polar Bears

Greenhouse Gas Emissions

Alaska

Global Warming

Endangered and Extinct Species

International Union for Conservation of Nature

National Snow and Ice Data Center

Polar Bears International

United States Geological Survey

希望这开始扩展您对如何使用这些 API 的想象。现在可能发生的事情非常令人兴奋。

当它结束时

New York Times API 非常有用,我很高兴看到他们将它提供给开发人员社区。通过 GitHub 获得如此快速的 API 支持也令人耳目一新——我只是没想到。请记住,它适用于非商业项目。如果您有一些赚钱的想法,请给他们发一封信,看看他们是否会与您合作。出版商渴望新的收入来源。

我希望您发现这些网络抓取片段很有帮助,并在您的项目中使用它们。如果你想看今天的节目,你可以在我的 网站 Active Together 上尝试一些网络抓取。

请在评论中分享任何想法和反馈。您也可以随时在 Twitter @lookahead_io 上直接与我联系。请务必查看我的讲师页面和其他关于使用 PHP 构建您的初创公司和使用 Yii2 编程的系列文章。

相关链接

php如何抓取网页数据( 如何利用PHP从网页中抓取通用元数据,以使您的用户更容易参与并构建更有趣的服务)

网站优化 • 优采云 发表了文章 • 0 个评论 • 58 次浏览 • 2022-03-06 01:01

如何利用PHP从网页中抓取通用元数据,以使您的用户更容易参与并构建更有趣的服务)

如何从网页中抓取元数据

介绍

我最近开始在 Yii 平台上建立一个社区站点,我很快就会在我的 Programming With Yii2 系列中写到。我想让添加与 网站 内容相关的链接变得容易。虽然人们很容易将 URL 粘贴到表单中,但同时提供标题和来源信息会变得很耗时。

在今天的教程中,我将向您展示如何利用 PHP 从网页中抓取通用元数据,以使您的用户更容易参与和构建更有趣的服务。

请记住,我参与了下面的评论线程,所以让我知道您的想法!您也可以在 Twitter @lookahead_io 上与我联系。

入门

首先,我构建了一个表单,供人们通过粘贴 URL 来添加链接。我还创建了一个查找按钮来使用 AJAX 请求元数据信息来抓取网页。

通过 ajax 调用函数,如 LookupLink::grab():

$(document).on("click", '[id=lookup]', function(event) {

$.ajax({

url: $('#url_prefix').val()+'/link/grab',

data: {url: $('#url').val()},

success: function(data) {

$('#title').val(data);

return true;

}

});

});

抓取页面

代码 Link::grab() 调用。fetch_og() 模仿爬虫抓取页面并使用 DOMXPath 获取元数据:

public static function fetch_og($url)

{

$options = array('http' => array('user_agent' => 'facebookexternalhit/1.1'));

$context = stream_context_create($options);

$data = file_get_contents($url,false,$context);

$dom = new \DomDocument;

@$dom->loadHTML($data);

$xpath = new \DOMXPath($dom);

# query metatags with og prefix

$metas = $xpath->query('//*/meta[starts-with(@property, \'og:\')]');

$og = array();

foreach($metas as $meta){

# get property name without og: prefix

$property = str_replace('og:', '', $meta->getAttribute('property'));

$content = $meta->getAttribute('content');

$og[$property] = $content;

}

return $og;

}

对于我的场景,我已经替换了上面的 og: 标签,但下面的代码会查找各种类型的标签:

$tags = Link::fetch_og($url);

if (isset($tags['title'])) {

$title = $tags['title'];

} else if (isset($tags['metaProperties']['og:title']['value'])) {

$title=$tags['metaProperties']['og:title']['value'];

} else {

$title = 'n/a';

}

return $title;

}

您还可以获取其他标签,例如关键字、描述等。jQuery 然后将结果添加到表单以供用户提交:

走得更远

我还有一个资源表,稍后我将进一步开发。但基本上,每次添加新 URL 时,我们都会将其解析为基础 网站 域并将其放入 Source 表中:

$model->source_id = Source::add($model->url);

...

public static function add($url='',$name='') {

$source_url = parse_url($url);

$url = $source_url['host'];

$url = trim($url,' \\');

$s = Source::find()

->where(['url'=>$url])

->one();

if (is_null($s)) {

$s=new Source;

$s->url = $url;

$s->name = $name;

$s->status = Source::STATUS_ACTIVE;

$s->save();

} else {

if ($s->name=='') {

$s->name = $name;

$s->update();

}

}

return $s->id;

}

现在,我正在手动更新来源的名称,以便它们对用户来说看起来很干净,例如 ABC News、BoingBoing 和 Vice:

希望在下一集中,我将回顾如何使用免费提供的 API 来查找站点名称。对我来说很奇怪,没有通用的元标记;如果只有互联网是完美的。

付费墙网站

像《纽约时报》这样的 网站 不允许您抓取元数据,因为有付费墙。但他们确实有一个 API。由于文档杂乱,学习起来并不容易,但他们的开发人员很快就可以在 GitHub 上提供帮助。我还希望写 文章 来介绍使用元数据在以后的剧集中找到 NYT 的头条新闻。

当它结束时

我希望你觉得这个抓取指南很有帮助,并在你的项目中使用它。如果你想看到它的实际效果,你可以在我的 网站 Active Together 上尝试一些网络抓取。

请在评论中分享任何想法和反馈。您也可以随时在 Twitter @lookahead_io 上直接与我联系。请务必查看我的讲师页面和我的其他系列,使用 PHP 构建您的初创公司和使用 Yii2 编程。

相关链接 查看全部

php如何抓取网页数据(

如何利用PHP从网页中抓取通用元数据,以使您的用户更容易参与并构建更有趣的服务)

如何从网页中抓取元数据

介绍

我最近开始在 Yii 平台上建立一个社区站点,我很快就会在我的 Programming With Yii2 系列中写到。我想让添加与 网站 内容相关的链接变得容易。虽然人们很容易将 URL 粘贴到表单中,但同时提供标题和来源信息会变得很耗时。

在今天的教程中,我将向您展示如何利用 PHP 从网页中抓取通用元数据,以使您的用户更容易参与和构建更有趣的服务。

请记住,我参与了下面的评论线程,所以让我知道您的想法!您也可以在 Twitter @lookahead_io 上与我联系。

入门

首先,我构建了一个表单,供人们通过粘贴 URL 来添加链接。我还创建了一个查找按钮来使用 AJAX 请求元数据信息来抓取网页。

通过 ajax 调用函数,如 LookupLink::grab():

$(document).on("click", '[id=lookup]', function(event) {

$.ajax({

url: $('#url_prefix').val()+'/link/grab',

data: {url: $('#url').val()},

success: function(data) {

$('#title').val(data);

return true;

}

});

});

抓取页面

代码 Link::grab() 调用。fetch_og() 模仿爬虫抓取页面并使用 DOMXPath 获取元数据:

public static function fetch_og($url)

{

$options = array('http' => array('user_agent' => 'facebookexternalhit/1.1'));

$context = stream_context_create($options);

$data = file_get_contents($url,false,$context);

$dom = new \DomDocument;

@$dom->loadHTML($data);

$xpath = new \DOMXPath($dom);

# query metatags with og prefix

$metas = $xpath->query('//*/meta[starts-with(@property, \'og:\')]');

$og = array();

foreach($metas as $meta){

# get property name without og: prefix

$property = str_replace('og:', '', $meta->getAttribute('property'));

$content = $meta->getAttribute('content');

$og[$property] = $content;

}

return $og;

}

对于我的场景,我已经替换了上面的 og: 标签,但下面的代码会查找各种类型的标签:

$tags = Link::fetch_og($url);

if (isset($tags['title'])) {

$title = $tags['title'];

} else if (isset($tags['metaProperties']['og:title']['value'])) {

$title=$tags['metaProperties']['og:title']['value'];

} else {

$title = 'n/a';

}

return $title;

}

您还可以获取其他标签,例如关键字、描述等。jQuery 然后将结果添加到表单以供用户提交:

走得更远

我还有一个资源表,稍后我将进一步开发。但基本上,每次添加新 URL 时,我们都会将其解析为基础 网站 域并将其放入 Source 表中:

$model->source_id = Source::add($model->url);

...

public static function add($url='',$name='') {

$source_url = parse_url($url);

$url = $source_url['host'];

$url = trim($url,' \\');

$s = Source::find()

->where(['url'=>$url])

->one();

if (is_null($s)) {

$s=new Source;

$s->url = $url;

$s->name = $name;

$s->status = Source::STATUS_ACTIVE;

$s->save();

} else {

if ($s->name=='') {

$s->name = $name;

$s->update();

}

}

return $s->id;

}

现在,我正在手动更新来源的名称,以便它们对用户来说看起来很干净,例如 ABC News、BoingBoing 和 Vice:

希望在下一集中,我将回顾如何使用免费提供的 API 来查找站点名称。对我来说很奇怪,没有通用的元标记;如果只有互联网是完美的。

付费墙网站

像《纽约时报》这样的 网站 不允许您抓取元数据,因为有付费墙。但他们确实有一个 API。由于文档杂乱,学习起来并不容易,但他们的开发人员很快就可以在 GitHub 上提供帮助。我还希望写 文章 来介绍使用元数据在以后的剧集中找到 NYT 的头条新闻。

当它结束时

我希望你觉得这个抓取指南很有帮助,并在你的项目中使用它。如果你想看到它的实际效果,你可以在我的 网站 Active Together 上尝试一些网络抓取。

请在评论中分享任何想法和反馈。您也可以随时在 Twitter @lookahead_io 上直接与我联系。请务必查看我的讲师页面和我的其他系列,使用 PHP 构建您的初创公司和使用 Yii2 编程。

相关链接

php如何抓取网页数据(这篇文章介绍闲来无事,刚学会把git部署到远程服务器 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 80 次浏览 • 2022-03-02 02:03

)

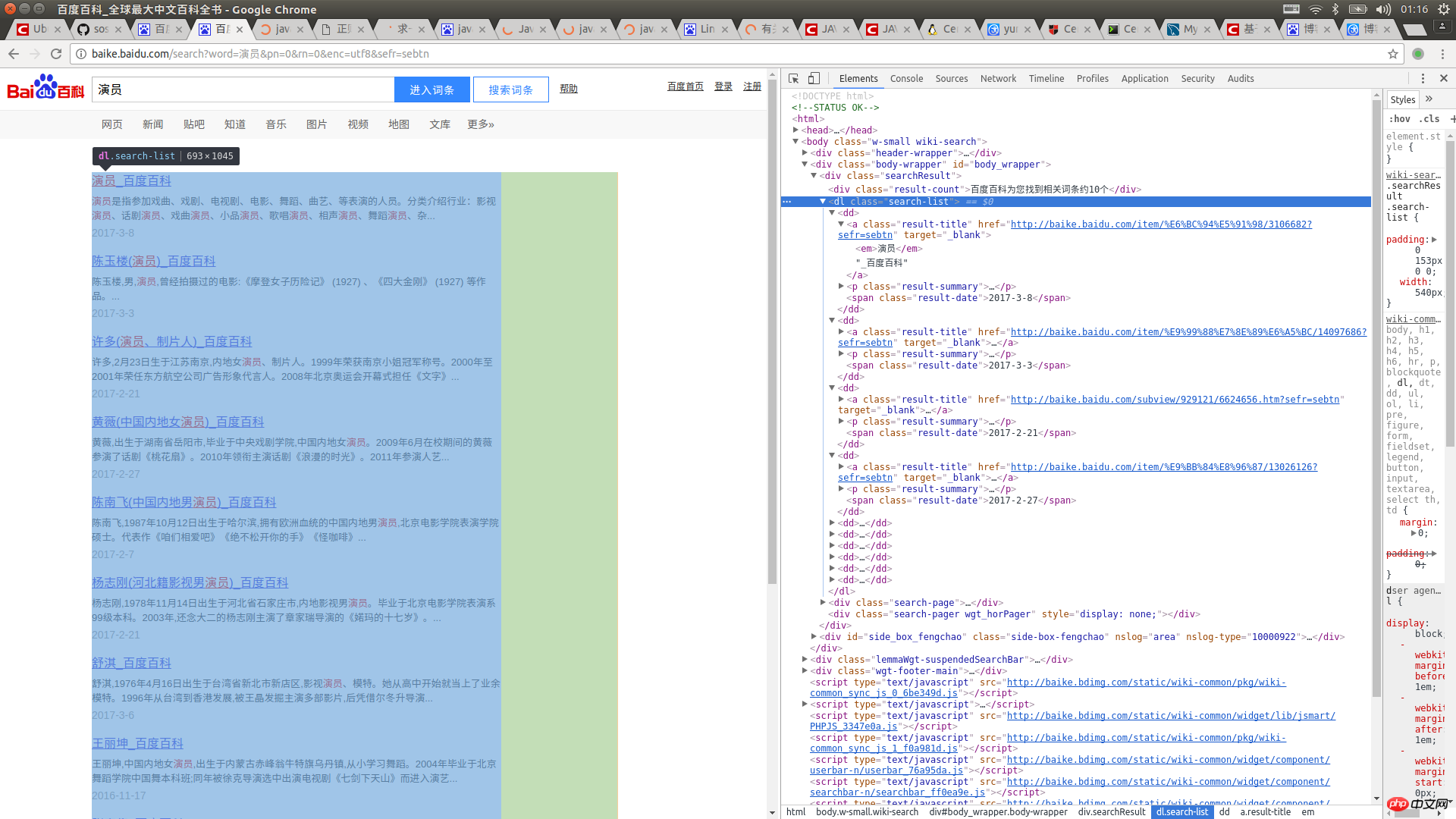

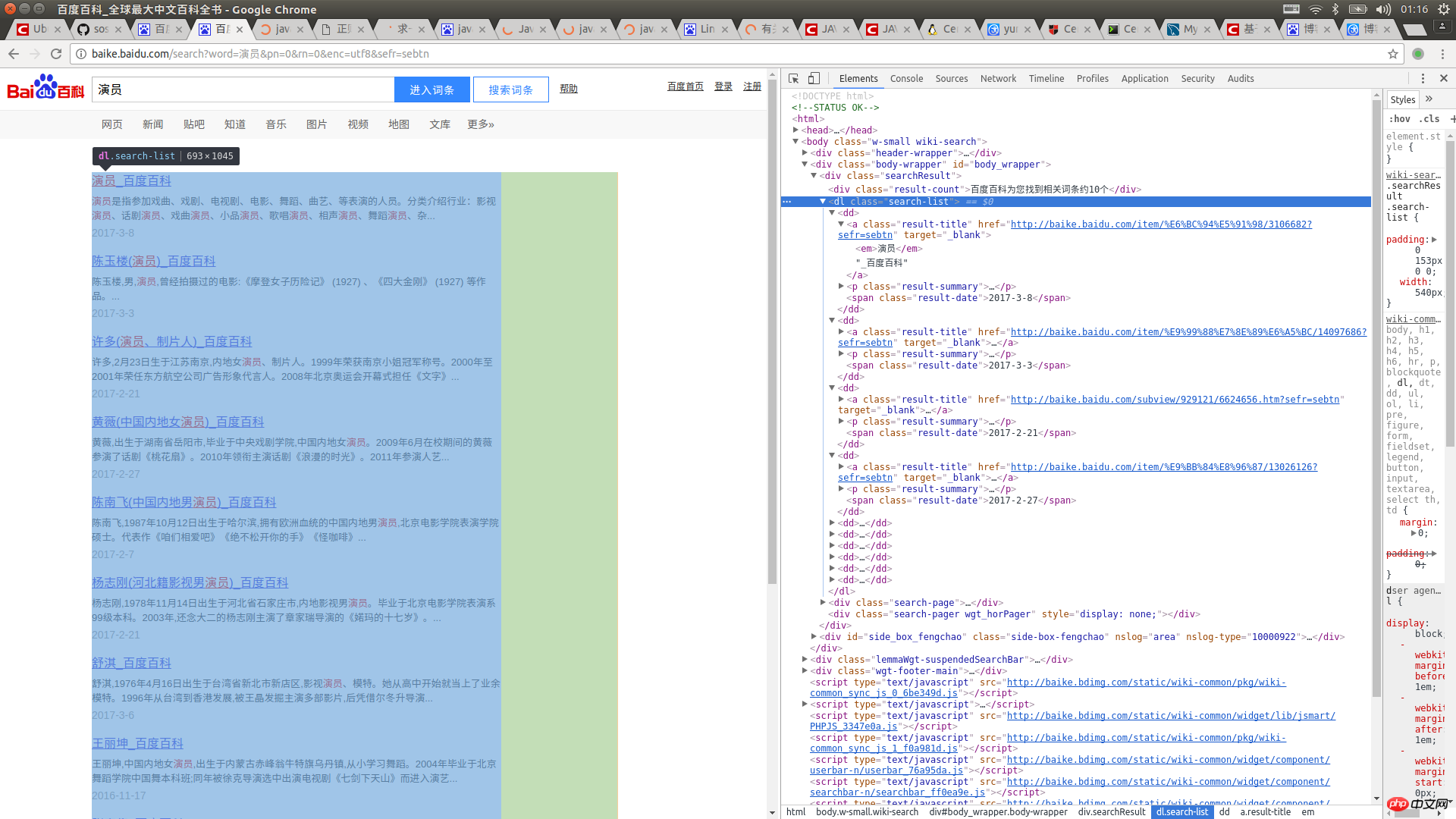

这篇文章介绍如何在java中使用url抓取网页内容

我没什么事,刚学会部署git到远程服务器,也没什么事,就干脆做了一个爬网页信息的小工具。如果将其中的一些值设置为参数,扩展性能可能会更好!我希望这是一个好的开始,也让我在阅读字符串方面更加精通。值得注意的是,在JAVA1.8中使用String拼接字符串时,会自动读取你想要的字符串。拼接后的字符串由StringBulider进行处理,极大的优化了String的性能。废话不多说,展示我的XXX码~

运行结果:

先打开百度百科,搜索词条,比如“演员”,然后按F12查看源码

然后抓取你想要的标签,注入到LinkedHashMap中,就ok了,很简单吧!看代码

import java.io.BufferedReader;

import java.io.IOException;

import java.io.InputStreamReader;

import java.net.HttpURLConnection;

import java.net.URL;

import java.util.*;

/**

* Created by chunmiao on 17-3-10.

*/

public class ReadBaiduSearch {

//储存返回结果

private LinkedHashMap mapOfBaike;

//获取搜索信息

public LinkedHashMap getInfomationOfBaike(String infomationWords) throws IOException {

mapOfBaike = getResult(infomationWords);

return mapOfBaike;

}

//通过网络链接获取信息

private static LinkedHashMap getResult(String keywords) throws IOException {

//搜索的url

String keyUrl = "http://baike.baidu.com/search?word=" + keywords;

//搜索词条的节点

String startNode = "";

//词条的链接关键字

String keyOfHref = "href=\"";

//词条的标题关键字

String keyOfTitle = "target=\"_blank\">";

String endNode = "";

boolean isNode = false;

String title;

String href;

String rLine;

LinkedHashMap keyMap = new LinkedHashMap();

//开始网络请求

URL url = new URL(keyUrl);

HttpURLConnection urlConnection = (HttpURLConnection) url.openConnection();

InputStreamReader inputStreamReader = new InputStreamReader(urlConnection.getInputStream(),"utf-8");

BufferedReader bufferedReader = new BufferedReader(inputStreamReader);

//读取网页内容

while ((rLine = bufferedReader.readLine()) != null){

//判断目标节点是否出现

if(rLine.contains(startNode)){

isNode = true;

}

//若目标节点出现,则开始抓取数据

if (isNode){

//若目标结束节点出现,则结束读取,节省读取时间

if (rLine.contains(endNode)) {

//关闭读取流

bufferedReader.close();

inputStreamReader.close();

break;

}

//若值为空则不读取

if (((title = getName(rLine,keyOfTitle)) != "") && ((href = getHref(rLine,keyOfHref)) != "")){

keyMap.put(title,href);

}

}

}

return keyMap;

}

//获取词条对应的url

private static String getHref(String rLine,String keyOfHref){

String baikeUrl = "http://baike.baidu.com";

String result = "";

if(rLine.contains(keyOfHref)){

//获取url

for (int j = rLine.indexOf(keyOfHref) + keyOfHref.length();j < rLine.length()&&(rLine.charAt(j) != '\"');j ++){

result += rLine.charAt(j);

}

//获取的url中可能不含baikeUrl,如果没有则在头部添加一个

if(!result.contains(baikeUrl)){

result = baikeUrl + result;

}

}

return result;

}

//获取词条对应的名称

private static String getName(String rLine,String keyOfTitle){

String result = "";

//获取标题内容

if(rLine.contains(keyOfTitle)){

result = rLine.substring(rLine.indexOf(keyOfTitle) + keyOfTitle.length(),rLine.length());

//将标题中的内容含有的标签去掉

result = result.replaceAll("||</a>|<a>","");

}

return result;

}

}

以上就是java中如何使用url抓取网页内容的详细内容。更多详情请关注php中文网文章其他相关话题!

查看全部

php如何抓取网页数据(这篇文章介绍闲来无事,刚学会把git部署到远程服务器

)

这篇文章介绍如何在java中使用url抓取网页内容

我没什么事,刚学会部署git到远程服务器,也没什么事,就干脆做了一个爬网页信息的小工具。如果将其中的一些值设置为参数,扩展性能可能会更好!我希望这是一个好的开始,也让我在阅读字符串方面更加精通。值得注意的是,在JAVA1.8中使用String拼接字符串时,会自动读取你想要的字符串。拼接后的字符串由StringBulider进行处理,极大的优化了String的性能。废话不多说,展示我的XXX码~

运行结果:

先打开百度百科,搜索词条,比如“演员”,然后按F12查看源码

然后抓取你想要的标签,注入到LinkedHashMap中,就ok了,很简单吧!看代码

import java.io.BufferedReader;

import java.io.IOException;

import java.io.InputStreamReader;

import java.net.HttpURLConnection;

import java.net.URL;

import java.util.*;

/**

* Created by chunmiao on 17-3-10.

*/

public class ReadBaiduSearch {

//储存返回结果

private LinkedHashMap mapOfBaike;

//获取搜索信息

public LinkedHashMap getInfomationOfBaike(String infomationWords) throws IOException {

mapOfBaike = getResult(infomationWords);

return mapOfBaike;

}

//通过网络链接获取信息

private static LinkedHashMap getResult(String keywords) throws IOException {

//搜索的url

String keyUrl = "http://baike.baidu.com/search?word=" + keywords;

//搜索词条的节点

String startNode = "";

//词条的链接关键字

String keyOfHref = "href=\"";

//词条的标题关键字

String keyOfTitle = "target=\"_blank\">";

String endNode = "";

boolean isNode = false;

String title;

String href;

String rLine;

LinkedHashMap keyMap = new LinkedHashMap();

//开始网络请求

URL url = new URL(keyUrl);

HttpURLConnection urlConnection = (HttpURLConnection) url.openConnection();

InputStreamReader inputStreamReader = new InputStreamReader(urlConnection.getInputStream(),"utf-8");

BufferedReader bufferedReader = new BufferedReader(inputStreamReader);

//读取网页内容

while ((rLine = bufferedReader.readLine()) != null){

//判断目标节点是否出现

if(rLine.contains(startNode)){

isNode = true;

}

//若目标节点出现,则开始抓取数据

if (isNode){

//若目标结束节点出现,则结束读取,节省读取时间

if (rLine.contains(endNode)) {

//关闭读取流

bufferedReader.close();

inputStreamReader.close();

break;

}

//若值为空则不读取

if (((title = getName(rLine,keyOfTitle)) != "") && ((href = getHref(rLine,keyOfHref)) != "")){

keyMap.put(title,href);

}

}

}

return keyMap;

}

//获取词条对应的url

private static String getHref(String rLine,String keyOfHref){

String baikeUrl = "http://baike.baidu.com";

String result = "";

if(rLine.contains(keyOfHref)){

//获取url

for (int j = rLine.indexOf(keyOfHref) + keyOfHref.length();j < rLine.length()&&(rLine.charAt(j) != '\"');j ++){

result += rLine.charAt(j);

}

//获取的url中可能不含baikeUrl,如果没有则在头部添加一个

if(!result.contains(baikeUrl)){

result = baikeUrl + result;

}

}

return result;

}

//获取词条对应的名称

private static String getName(String rLine,String keyOfTitle){

String result = "";

//获取标题内容

if(rLine.contains(keyOfTitle)){

result = rLine.substring(rLine.indexOf(keyOfTitle) + keyOfTitle.length(),rLine.length());

//将标题中的内容含有的标签去掉

result = result.replaceAll("||</a>|<a>","");

}

return result;

}

}

以上就是java中如何使用url抓取网页内容的详细内容。更多详情请关注php中文网文章其他相关话题!

php如何抓取网页数据(php如何抓取网页数据(1)_网页爬虫:逆袭之路三)

网站优化 • 优采云 发表了文章 • 0 个评论 • 69 次浏览 • 2022-02-21 17:01

php如何抓取网页数据

1)php如何抓取网页数据

2)php如何抓取网页数据

3)php如何抓取网页数据

4)网页爬虫:逆袭之路

五)php也能爬虫

四)网页抓取:逆袭之路

三)网页抓取:逆袭之路

二)网页抓取:逆袭之路

一)php抓取网页数据

二)

这种问题只能说是黑题主。php做网站数据抓取需要编程基础还有页面构造能力。对于初学者很难有优势。建议学java或者python,不用去考虑tcp或udp,更加复杂的路由系统也不需要,java的ajax技术和jquery即可解决一切。学会写爬虫代码之后就更没有优势。

从转型到爬虫也有一年多了,现在有了一个稳定的网站,有了一些想法就在知乎上实践,现在在上手基础的php爬虫,不知道方向对不对,请各位大神提点,给个方向,让我坚持一下看看,

别看了,他们在用php实现的网站数据抓取工作大多都是通过各种网站爬虫,其实你去新闻门户站看看也是如此,比如凤凰网,甚至手机的,都是爬虫在抓,和网站有什么关系,

必须懂爬虫的相关东西,懂一点点http协议,以及http协议请求,一般都会抓取返回的数据。可以找些网站自己用php先去爬一下,抓取一下http协议得到一些trace值,自己看看server那边是怎么搞得。 查看全部

php如何抓取网页数据(php如何抓取网页数据(1)_网页爬虫:逆袭之路三)

php如何抓取网页数据

1)php如何抓取网页数据

2)php如何抓取网页数据

3)php如何抓取网页数据

4)网页爬虫:逆袭之路

五)php也能爬虫

四)网页抓取:逆袭之路

三)网页抓取:逆袭之路

二)网页抓取:逆袭之路

一)php抓取网页数据

二)

这种问题只能说是黑题主。php做网站数据抓取需要编程基础还有页面构造能力。对于初学者很难有优势。建议学java或者python,不用去考虑tcp或udp,更加复杂的路由系统也不需要,java的ajax技术和jquery即可解决一切。学会写爬虫代码之后就更没有优势。

从转型到爬虫也有一年多了,现在有了一个稳定的网站,有了一些想法就在知乎上实践,现在在上手基础的php爬虫,不知道方向对不对,请各位大神提点,给个方向,让我坚持一下看看,

别看了,他们在用php实现的网站数据抓取工作大多都是通过各种网站爬虫,其实你去新闻门户站看看也是如此,比如凤凰网,甚至手机的,都是爬虫在抓,和网站有什么关系,

必须懂爬虫的相关东西,懂一点点http协议,以及http协议请求,一般都会抓取返回的数据。可以找些网站自己用php先去爬一下,抓取一下http协议得到一些trace值,自己看看server那边是怎么搞得。

php如何抓取网页数据(哪些网页才能被保存到搜索引擎的服务器上呢?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 60 次浏览 • 2022-02-20 23:08

什么是搜索引擎蜘蛛机器人?它是如何工作的?

互联网发展初期,网站比较少,找资料比较容易。然而,随着互联网的爆炸式发展,普通网民要想找到自己需要的信息,就如同大海捞针。这时,满足公共信息检索需求的专业搜索网站应运而生。

现代搜索引擎的鼻祖是 Archie,它是由蒙特利尔大学的学生 Alan Emtage 于 1990 年发明的。虽然当时万维网还没有出现,但网络中的文件传输仍然相当频繁,而且由于大量文件分散在各个分散的 FTP 主机中,查询起来很不方便,所以艾伦·埃姆塔奇想到了开发一个可以搜索的文件名。文件系统,所以有Archie。

Archie 的工作原理与现在的搜索引擎非常接近。它依靠脚本程序自动搜索互联网上的文件,然后将相关信息编入索引,供用户以一定的表达方式查询。受到 Archie 在用户中的受欢迎程度的启发,内华达大学系统计算服务公司在 1993 年开发了另一个非常相似的搜索工具,但这次搜索工具除了索引文件之外还能够检索网页。

当时,“机器人”这个词在程序员中非常流行。计算机“机器人”是一种软件程序,可以以人类无法做到的速度不间断地执行任务。因为专门用于检索信息的“机器人”程序像蜘蛛一样在网上爬行,所以搜索引擎的“机器人”程序被称为“蜘蛛”程序。

先说一下搜索引擎的原理。

搜索引擎将互联网上的网页内容存储在自己的服务器上。当用户搜索某个词时,搜索引擎会在自己的服务器上找到相关内容。也就是说,只搜索存储在搜索引擎服务器网页上的内容。哪些网页可以保存到搜索引擎的服务器上?只有搜索引擎的网络爬虫程序抓取到的网页才会保存在搜索引擎的服务器上。这个网络爬虫程序是搜索引擎的蜘蛛。

蜘蛛机器人如何工作(搜索引擎如何工作)

您应该知道在搜索引擎结果页面中排名靠前的重要性。但是,您的 网站 没有进入前三页,您不明白为什么。当蜘蛛侠想要索引您的页面时,您可能会混淆它。那么你是怎么知道的呢?别担心,继续阅读。

你有一个很棒的 网站 有很多相关的内容,但你不能总是在搜索结果页面上排名靠前。您还知道,如果您的 网站 未在前几页中列出,则搜索者很有可能找不到该页面。您无法理解为什么页面对谷歌和其他主要搜索引擎不可见。而且你的竞争对手的网页不如你的,但排名比你的高。

搜索引擎不是人类。搜索引擎公司几乎完全自动化了这个过程,以便处理万维网上收录的数百万个页面。软件程序不会像人眼那样看到您的网页。这并不是说您不需要让访问者高兴的 网站。这意味着您需要意识到搜索引擎会以不同的方式“看到”您的页面,并相应地进行计划。

尽管网络很复杂,所有数据的处理速度很快,但搜索引擎实际上会执行简短的操作来将相关结果反馈给用户。这四个操作中的每一个都可能出错。这并不是说搜索引擎本身有问题,它可能只是遇到了一些它没有程序可以处理的东西。或者它被编程来处理它遇到的所有事情的方式都会产生次优的结果。

了解搜索引擎的运作方式可以帮助您了解可能出现的问题。所有搜索引擎都完成四项主要任务:

网站抓住。搜索引擎发送自动程序,有时称为“蜘蛛侠”,使用网页的超链接结构来抓取网页。根据我们的一些最佳估计,搜索引擎蜘蛛现在已经爬上了网络一侧的页面。

文件检索。蜘蛛侠爬到某个网页后,应该把它的内容变成一个模板,当用户向搜索引擎提问时,它就会很容易回复。通过这种方式,网页被分组在一个庞大的、严格管理的数据库中,该数据库构成了搜索引擎的索引。这些索引包括数十亿份文档,并在不到一秒的时间内呈现给消费者。

审讯程序。当用户使用搜索引擎时,引擎会检查其索引以查找匹配的文档。表面上看起来非常相似的问题可能会产生非常不同的结果。恰当的例子:在 Google 上搜索“field and river magazine”(不带引号)会产生超过 400 万条结果。加上引号,谷歌只返回了 19,600 个结果。这只是搜索者缩小搜索量并获得相关结果的一种方式。

排名结果。谷歌并没有向你展示全部 19,600 个结果,即便如此,它也需要某种方式来决定将哪些结果排在第一位。因此搜索引擎运行一种算法来确定哪些与搜索最相关。这些列在最前面,其余的按相关性顺序向下列出。

现在你应该对整个过程有了一些了解。只需花一些时间近距离观察每一个。这将帮助您了解事情进展如何,以及某些任务如何以及为什么会变得糟糕。这个 文章 将专注于网络抓取。

不爬行,而是阻挡

当你开始 网站navigation 时,它主要是你的真实世界的访问者,当然它应该是。但是一些导航结构可能会阻止搜索引擎蜘蛛,使它们一开始就不太容易发现您的页面。作为额外的奖励,您对网页所做的许多事情都将使蜘蛛侠更容易找到 网站 内容,从而使访问者更容易在页面中找到自己的方式。

顺便说一句,您可能不希望蜘蛛侠能够索引您页面上的所有内容,但您应该记住这一点。如果您有一个需要付费才能访问的页面,您可能不希望 Google 抓取您的内容以将其显示给输入 关键词 的任何人。有很多方法可以人为地阻止蜘蛛侠捕捉到这些内容。

动态 URL 是对搜索引擎蜘蛛的最大威慑之一。特别是具有两个或更多动态参数的页面将配备蜘蛛侠。当您看到动态 URL 时,您会认出它,该 URL 通常收录许多“垃圾”符号,例如问号、等号、和号 (&) 和百分号。这些页面对人类用户来说很好,他们将通过设置一些参数来获得。例如,在搜索框中输入邮政编码将返回收录特定区域天气状况的页面以及收录动态 URL 的页面位置。

蜘蛛侠还有很多其他不喜欢的方式。例如,在同一个 URL 上具有一百多个超链接的页面可能会让他们厌倦地查看它们。蜘蛛侠不会关注这些链接。如果你试图建立一个网站地图,有更好的方法来阻止他。

隐藏在页面上的主页链接超过三个的页面也不会被抓取。因为这会使许多人对网页上的如此多链接而没有导航感到头晕目眩。

需要“身份验证”等的页面也不会被抓取。蜘蛛侠不是扫描仪,它们的能力也不相同。他们可能无法保持相同形式的验证。

另一个块是分成框架的网页。许多网页设计师喜欢框架;它使访问者即使在浏览内容时也保持在同一页面上,但蜘蛛侠发现框架网页令人困惑。对他们来说,内容就是内容,他们不知道哪个网页应该出现在搜索结果页面上。坦率地说,许多用户也不喜欢框架,只是为了提供更干净的页面。

上面阻止蜘蛛侠工作的大部分内容都是你不小心放在页面上的。让我们谈谈 网站 管理员故意用来阻止蜘蛛侠的一些事情。前面我提到过,其中一个主要原因是内容需要用户付费才能看到,还有一些其他的,比如内容可能是免费的,但不是每个人都能轻松获得。

网站填写一些表格并提交进入,蜘蛛侠很有可能会被关闭。他们无法获得按钮或类型。同样,需要使用下拉菜单的网页可能无法搜索,只能通过搜索框访问的文档也可能无法搜索。

故意阻止的文件通常不会被抓取。

现在你知道是什么让蜘蛛侠窒息了,你可以如何鼓励他们去任何他们想去的地方。关键是为您希望蜘蛛侠访问的每个页面提供直接的 HTML 链接。另外,给他们一个浅水池玩。蜘蛛侠通常从主页开始,如果您的网页的某些部分无法从那里访问,蜘蛛侠很可能看不到它。此时使用 网站maps 是非常宝贵的。

蜘蛛侠在超链接中看到了什么?

我假设您对 HTML 相当熟悉。如果你看过 HTML 页面的代码,你可能已经注意到出现超链接的文本,seo Chat

当 网站 浏览器读到这个时,它会知道文本“seo chat”应该是一个超链接页面。顺便说一下,在这个例子中,“seo chat”是链接的前导词。当蜘蛛阅读这段文字时,它会认为,“OK,该页面”与当前页面上的文字相关,与“SEO CHAT”极为相关。

现在对于更复杂的:

标题=“搜索引擎优化信息的好网站”

Rel=”nofollow”>seo 聊天

现在怎么样了?引导词没有改变,所以当网络浏览器在这里显示它时,链接看起来还是一样的。但是蜘蛛侠会想,“好吧,这个页面不仅与‘seochat’相关,而且与‘伟大的 seo 信息网站’相关。而且,我现在所在的这个页面与这个超链接相关。它显示该链接不是对该页面的投票,因此不会增加 PR 值。”

最后一点,关于这个链接不是对该页面的投票,反映在标签“rel=nofollow”中。这个标签演变成一个链接,指向向博客“欢迎使用我的药物网站”提交相关评论的人。这种评论方式是为了提升自己页面的搜索排名的一种尝试。这称为“评论垃圾邮件”。大多数搜索引擎不喜欢垃圾评论,因为它会歪曲他们的结果,使它们的相关性降低。正如您可能猜到的那样,“nofollow”属性对于搜索引擎来说是特殊的,它不会被注意到。雅虎、MSN、谷歌都可以识别,但 askjeeves 不支持 nofollow,它的蜘蛛侠只是忽略了标签。

在某些情况下,链接可能指向图像。超链接将包括照片的名称和可能的“alt”属性的一些替代文本,这对于盲人的语音浏览器很有帮助。它还有助于蜘蛛侠,因为它提供了另一个页面描述的证据。

网页上可能还有其他形式的超链接,但一般来说,这些形式不会通过排名或蜘蛛侠值。总而言之,链接越接近文字的形式,蜘蛛侠就越容易抓取链接,反之亦然。 查看全部

php如何抓取网页数据(哪些网页才能被保存到搜索引擎的服务器上呢?)

什么是搜索引擎蜘蛛机器人?它是如何工作的?

互联网发展初期,网站比较少,找资料比较容易。然而,随着互联网的爆炸式发展,普通网民要想找到自己需要的信息,就如同大海捞针。这时,满足公共信息检索需求的专业搜索网站应运而生。

现代搜索引擎的鼻祖是 Archie,它是由蒙特利尔大学的学生 Alan Emtage 于 1990 年发明的。虽然当时万维网还没有出现,但网络中的文件传输仍然相当频繁,而且由于大量文件分散在各个分散的 FTP 主机中,查询起来很不方便,所以艾伦·埃姆塔奇想到了开发一个可以搜索的文件名。文件系统,所以有Archie。

Archie 的工作原理与现在的搜索引擎非常接近。它依靠脚本程序自动搜索互联网上的文件,然后将相关信息编入索引,供用户以一定的表达方式查询。受到 Archie 在用户中的受欢迎程度的启发,内华达大学系统计算服务公司在 1993 年开发了另一个非常相似的搜索工具,但这次搜索工具除了索引文件之外还能够检索网页。

当时,“机器人”这个词在程序员中非常流行。计算机“机器人”是一种软件程序,可以以人类无法做到的速度不间断地执行任务。因为专门用于检索信息的“机器人”程序像蜘蛛一样在网上爬行,所以搜索引擎的“机器人”程序被称为“蜘蛛”程序。

先说一下搜索引擎的原理。

搜索引擎将互联网上的网页内容存储在自己的服务器上。当用户搜索某个词时,搜索引擎会在自己的服务器上找到相关内容。也就是说,只搜索存储在搜索引擎服务器网页上的内容。哪些网页可以保存到搜索引擎的服务器上?只有搜索引擎的网络爬虫程序抓取到的网页才会保存在搜索引擎的服务器上。这个网络爬虫程序是搜索引擎的蜘蛛。

蜘蛛机器人如何工作(搜索引擎如何工作)

您应该知道在搜索引擎结果页面中排名靠前的重要性。但是,您的 网站 没有进入前三页,您不明白为什么。当蜘蛛侠想要索引您的页面时,您可能会混淆它。那么你是怎么知道的呢?别担心,继续阅读。

你有一个很棒的 网站 有很多相关的内容,但你不能总是在搜索结果页面上排名靠前。您还知道,如果您的 网站 未在前几页中列出,则搜索者很有可能找不到该页面。您无法理解为什么页面对谷歌和其他主要搜索引擎不可见。而且你的竞争对手的网页不如你的,但排名比你的高。

搜索引擎不是人类。搜索引擎公司几乎完全自动化了这个过程,以便处理万维网上收录的数百万个页面。软件程序不会像人眼那样看到您的网页。这并不是说您不需要让访问者高兴的 网站。这意味着您需要意识到搜索引擎会以不同的方式“看到”您的页面,并相应地进行计划。

尽管网络很复杂,所有数据的处理速度很快,但搜索引擎实际上会执行简短的操作来将相关结果反馈给用户。这四个操作中的每一个都可能出错。这并不是说搜索引擎本身有问题,它可能只是遇到了一些它没有程序可以处理的东西。或者它被编程来处理它遇到的所有事情的方式都会产生次优的结果。

了解搜索引擎的运作方式可以帮助您了解可能出现的问题。所有搜索引擎都完成四项主要任务:

网站抓住。搜索引擎发送自动程序,有时称为“蜘蛛侠”,使用网页的超链接结构来抓取网页。根据我们的一些最佳估计,搜索引擎蜘蛛现在已经爬上了网络一侧的页面。

文件检索。蜘蛛侠爬到某个网页后,应该把它的内容变成一个模板,当用户向搜索引擎提问时,它就会很容易回复。通过这种方式,网页被分组在一个庞大的、严格管理的数据库中,该数据库构成了搜索引擎的索引。这些索引包括数十亿份文档,并在不到一秒的时间内呈现给消费者。

审讯程序。当用户使用搜索引擎时,引擎会检查其索引以查找匹配的文档。表面上看起来非常相似的问题可能会产生非常不同的结果。恰当的例子:在 Google 上搜索“field and river magazine”(不带引号)会产生超过 400 万条结果。加上引号,谷歌只返回了 19,600 个结果。这只是搜索者缩小搜索量并获得相关结果的一种方式。

排名结果。谷歌并没有向你展示全部 19,600 个结果,即便如此,它也需要某种方式来决定将哪些结果排在第一位。因此搜索引擎运行一种算法来确定哪些与搜索最相关。这些列在最前面,其余的按相关性顺序向下列出。

现在你应该对整个过程有了一些了解。只需花一些时间近距离观察每一个。这将帮助您了解事情进展如何,以及某些任务如何以及为什么会变得糟糕。这个 文章 将专注于网络抓取。

不爬行,而是阻挡

当你开始 网站navigation 时,它主要是你的真实世界的访问者,当然它应该是。但是一些导航结构可能会阻止搜索引擎蜘蛛,使它们一开始就不太容易发现您的页面。作为额外的奖励,您对网页所做的许多事情都将使蜘蛛侠更容易找到 网站 内容,从而使访问者更容易在页面中找到自己的方式。

顺便说一句,您可能不希望蜘蛛侠能够索引您页面上的所有内容,但您应该记住这一点。如果您有一个需要付费才能访问的页面,您可能不希望 Google 抓取您的内容以将其显示给输入 关键词 的任何人。有很多方法可以人为地阻止蜘蛛侠捕捉到这些内容。

动态 URL 是对搜索引擎蜘蛛的最大威慑之一。特别是具有两个或更多动态参数的页面将配备蜘蛛侠。当您看到动态 URL 时,您会认出它,该 URL 通常收录许多“垃圾”符号,例如问号、等号、和号 (&) 和百分号。这些页面对人类用户来说很好,他们将通过设置一些参数来获得。例如,在搜索框中输入邮政编码将返回收录特定区域天气状况的页面以及收录动态 URL 的页面位置。

蜘蛛侠还有很多其他不喜欢的方式。例如,在同一个 URL 上具有一百多个超链接的页面可能会让他们厌倦地查看它们。蜘蛛侠不会关注这些链接。如果你试图建立一个网站地图,有更好的方法来阻止他。

隐藏在页面上的主页链接超过三个的页面也不会被抓取。因为这会使许多人对网页上的如此多链接而没有导航感到头晕目眩。

需要“身份验证”等的页面也不会被抓取。蜘蛛侠不是扫描仪,它们的能力也不相同。他们可能无法保持相同形式的验证。

另一个块是分成框架的网页。许多网页设计师喜欢框架;它使访问者即使在浏览内容时也保持在同一页面上,但蜘蛛侠发现框架网页令人困惑。对他们来说,内容就是内容,他们不知道哪个网页应该出现在搜索结果页面上。坦率地说,许多用户也不喜欢框架,只是为了提供更干净的页面。

上面阻止蜘蛛侠工作的大部分内容都是你不小心放在页面上的。让我们谈谈 网站 管理员故意用来阻止蜘蛛侠的一些事情。前面我提到过,其中一个主要原因是内容需要用户付费才能看到,还有一些其他的,比如内容可能是免费的,但不是每个人都能轻松获得。

网站填写一些表格并提交进入,蜘蛛侠很有可能会被关闭。他们无法获得按钮或类型。同样,需要使用下拉菜单的网页可能无法搜索,只能通过搜索框访问的文档也可能无法搜索。

故意阻止的文件通常不会被抓取。

现在你知道是什么让蜘蛛侠窒息了,你可以如何鼓励他们去任何他们想去的地方。关键是为您希望蜘蛛侠访问的每个页面提供直接的 HTML 链接。另外,给他们一个浅水池玩。蜘蛛侠通常从主页开始,如果您的网页的某些部分无法从那里访问,蜘蛛侠很可能看不到它。此时使用 网站maps 是非常宝贵的。

蜘蛛侠在超链接中看到了什么?

我假设您对 HTML 相当熟悉。如果你看过 HTML 页面的代码,你可能已经注意到出现超链接的文本,seo Chat

当 网站 浏览器读到这个时,它会知道文本“seo chat”应该是一个超链接页面。顺便说一下,在这个例子中,“seo chat”是链接的前导词。当蜘蛛阅读这段文字时,它会认为,“OK,该页面”与当前页面上的文字相关,与“SEO CHAT”极为相关。

现在对于更复杂的:

标题=“搜索引擎优化信息的好网站”

Rel=”nofollow”>seo 聊天

现在怎么样了?引导词没有改变,所以当网络浏览器在这里显示它时,链接看起来还是一样的。但是蜘蛛侠会想,“好吧,这个页面不仅与‘seochat’相关,而且与‘伟大的 seo 信息网站’相关。而且,我现在所在的这个页面与这个超链接相关。它显示该链接不是对该页面的投票,因此不会增加 PR 值。”

最后一点,关于这个链接不是对该页面的投票,反映在标签“rel=nofollow”中。这个标签演变成一个链接,指向向博客“欢迎使用我的药物网站”提交相关评论的人。这种评论方式是为了提升自己页面的搜索排名的一种尝试。这称为“评论垃圾邮件”。大多数搜索引擎不喜欢垃圾评论,因为它会歪曲他们的结果,使它们的相关性降低。正如您可能猜到的那样,“nofollow”属性对于搜索引擎来说是特殊的,它不会被注意到。雅虎、MSN、谷歌都可以识别,但 askjeeves 不支持 nofollow,它的蜘蛛侠只是忽略了标签。

在某些情况下,链接可能指向图像。超链接将包括照片的名称和可能的“alt”属性的一些替代文本,这对于盲人的语音浏览器很有帮助。它还有助于蜘蛛侠,因为它提供了另一个页面描述的证据。

网页上可能还有其他形式的超链接,但一般来说,这些形式不会通过排名或蜘蛛侠值。总而言之,链接越接近文字的形式,蜘蛛侠就越容易抓取链接,反之亦然。

php如何抓取网页数据(PHP的curl()设置相关选项信息的使用总结)

网站优化 • 优采云 发表了文章 • 0 个评论 • 67 次浏览 • 2022-02-16 01:23

PHP 的 curl() 爬取网页的效率相对较高,并且支持多线程,而 file_get_contents() 的效率略低。当然,使用 curl 时需要启用 curl 扩展。

代码实战

我们先看登录部分的代码:

//模拟登录

function login_post($url, $cookie, $post) {

$curl = curl_init();//初始化curl模块

curl_setopt($curl, CURLOPT_URL, $url);//登录提交的地址

curl_setopt($curl, CURLOPT_HEADER, 0);//是否显示头信息

curl_setopt($curl, CURLOPT_RETURNTRANSFER, 0);//是否自动显示返回的信息

curl_setopt($curl, CURLOPT_COOKIEJAR, $cookie); //设置Cookie信息保存在指定的文件中

curl_setopt($curl, CURLOPT_POST, 1);//post方式提交

curl_setopt($curl, CURLOPT_POSTFIELDS, http_build_query($post));//要提交的信息

curl_exec($curl);//执行cURL

curl_close($curl);//关闭cURL资源,并且释放系统资源

}

login_post()函数首先初始化curl_init(),然后使用curl_setopt()设置相关选项信息,包括要提交的url地址、保存的cookie文件、post数据(用户名和密码等)、是否提交返回信息等,然后curl_exec执行curl,最后curl_close()释放资源。请注意,PHP 自己的 http_build_query() 可以将数组转换为连接字符串。

接下来,如果登录成功,我们需要获取登录成功后的页面信息。

//登录成功后获取数据

function get_content($url, $cookie) {

$ch = curl_init();

curl_setopt($ch, CURLOPT_URL, $url);

curl_setopt($ch, CURLOPT_HEADER, 0);

curl_setopt($ch, CURLOPT_RETURNTRANSFER, 1);

curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie); //读取cookie

$rs = curl_exec($ch); //执行cURL抓取页面内容

curl_close($ch);

return $rs;

}

函数get_content()也是先初始化curl,然后设置相关选项,执行curl,释放资源。其中,我们将CURLOPT_RETURNTRANSFER设置为1自动返回信息,CURLOPT_COOKIEFILE可以读取登录时保存的cookie信息,最终返回页面内容。

我们的最终目标是获取模拟登录后的信息,即只有正常登录成功后才能获取的有用信息。下面我们以登录开源中国手机版为例,看看登录成功后如何获取信息。

//设置post的数据

$post = array (

'email' => 'oschina账户',

'pwd' => 'oschina密码',

'goto_page' => '/my',

'error_page' => '/login',

'save_login' => '1',

'submit' => '现在登录'

);

//登录地址

$url = "http://m.oschina.net/action/user/login";

//设置cookie保存路径

$cookie = dirname(__FILE__) . '/cookie_oschina.txt';

//登录后要获取信息的地址

$url2 = "http://m.oschina.net/my";

//模拟登录

login_post($url, $cookie, $post);

//获取登录页的信息

$content = get_content($url2, $cookie);

//删除cookie文件

@ unlink($cookie);

//匹配页面信息

$preg = "/(.*)/i";

preg_match_all($preg, $content, $arr);

$str = $arr[1][0];

//输出内容

echo $str;

运行上面的代码后,我们会看到最终得到了登录用户的头像。

使用总结

1、初始化卷曲;

2、使用 curl_setopt 设置目标 url 等选项;

3、curl_exec,执行curl;

4、 执行后关闭curl;

5、输出数据。 查看全部

php如何抓取网页数据(PHP的curl()设置相关选项信息的使用总结)

PHP 的 curl() 爬取网页的效率相对较高,并且支持多线程,而 file_get_contents() 的效率略低。当然,使用 curl 时需要启用 curl 扩展。

代码实战

我们先看登录部分的代码:

//模拟登录

function login_post($url, $cookie, $post) {

$curl = curl_init();//初始化curl模块

curl_setopt($curl, CURLOPT_URL, $url);//登录提交的地址

curl_setopt($curl, CURLOPT_HEADER, 0);//是否显示头信息

curl_setopt($curl, CURLOPT_RETURNTRANSFER, 0);//是否自动显示返回的信息

curl_setopt($curl, CURLOPT_COOKIEJAR, $cookie); //设置Cookie信息保存在指定的文件中

curl_setopt($curl, CURLOPT_POST, 1);//post方式提交

curl_setopt($curl, CURLOPT_POSTFIELDS, http_build_query($post));//要提交的信息

curl_exec($curl);//执行cURL

curl_close($curl);//关闭cURL资源,并且释放系统资源

}

login_post()函数首先初始化curl_init(),然后使用curl_setopt()设置相关选项信息,包括要提交的url地址、保存的cookie文件、post数据(用户名和密码等)、是否提交返回信息等,然后curl_exec执行curl,最后curl_close()释放资源。请注意,PHP 自己的 http_build_query() 可以将数组转换为连接字符串。

接下来,如果登录成功,我们需要获取登录成功后的页面信息。

//登录成功后获取数据

function get_content($url, $cookie) {

$ch = curl_init();

curl_setopt($ch, CURLOPT_URL, $url);

curl_setopt($ch, CURLOPT_HEADER, 0);

curl_setopt($ch, CURLOPT_RETURNTRANSFER, 1);

curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie); //读取cookie

$rs = curl_exec($ch); //执行cURL抓取页面内容

curl_close($ch);

return $rs;

}

函数get_content()也是先初始化curl,然后设置相关选项,执行curl,释放资源。其中,我们将CURLOPT_RETURNTRANSFER设置为1自动返回信息,CURLOPT_COOKIEFILE可以读取登录时保存的cookie信息,最终返回页面内容。

我们的最终目标是获取模拟登录后的信息,即只有正常登录成功后才能获取的有用信息。下面我们以登录开源中国手机版为例,看看登录成功后如何获取信息。

//设置post的数据

$post = array (

'email' => 'oschina账户',

'pwd' => 'oschina密码',

'goto_page' => '/my',

'error_page' => '/login',

'save_login' => '1',

'submit' => '现在登录'

);

//登录地址

$url = "http://m.oschina.net/action/user/login";

//设置cookie保存路径

$cookie = dirname(__FILE__) . '/cookie_oschina.txt';

//登录后要获取信息的地址

$url2 = "http://m.oschina.net/my";

//模拟登录

login_post($url, $cookie, $post);

//获取登录页的信息

$content = get_content($url2, $cookie);

//删除cookie文件

@ unlink($cookie);

//匹配页面信息

$preg = "/(.*)/i";

preg_match_all($preg, $content, $arr);

$str = $arr[1][0];

//输出内容

echo $str;

运行上面的代码后,我们会看到最终得到了登录用户的头像。

使用总结

1、初始化卷曲;

2、使用 curl_setopt 设置目标 url 等选项;

3、curl_exec,执行curl;

4、 执行后关闭curl;

5、输出数据。

php如何抓取网页数据(纯静态网站在网站中是怎么进行静态化处理呢?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 67 次浏览 • 2022-02-16 01:20

随着网站内容和用户访问量的增加,带宽的限制和服务器同时请求的数量也在增加。让爱站技术频道的小编带你看看PHP实现。HTML页面静态方法!

一般会从以下几个方面进行优化

现在很多网站在构建的时候都需要静态处理,为什么网站要静态处理呢?我们都知道纯静态网站就是所有的网页都是独立的html页面。我们访问的时候可以直接读取文件,无需数据处理,访问速度可想而知。而且对于搜索引擎来说也是一种非常友好的方式。

网站 中的纯静态 网站 是如何实现的?

纯静态制作技术需要先对网站的页面进行汇总,分成若干样式,然后将这些页面制作成模板。生成的时候需要先读取源文件,然后生成一个独立的以.html结尾的,所以纯静态网站需要的空间比较大,但其实需要的空间并不多,尤其是中小型——大企业网站,从技术上讲,大网站很难做到全站纯静态,生成时间太长。不过中小网站还是做纯静态比较,有很多好处。

动态 网站 是如何静态处理的?

页面静态是指将动态页面变成html/htm静态页面。动态页面一般都是用asp、php、jsp、.net等编程语言编写的,非常好管理。但是在访问网页时,需要先处理程序,所以访问速度比较慢。静态页面访问速度快,但不易管理。那么动态页面静态可以将两个页面的好处结合在一起。

静态处理给网站带来什么好处?

静态处理的网站比没有静态处理的网站更安全,因为静态网站不是黑客攻击的首选,因为黑客不知道你的后台情况系统,黑客很难从前台的静态页面进行攻击。同时,它也具有一定的稳定性。比如网站的数据库或者程序有问题,不会干扰静态处理的页面,不会因为程序或者数据的影响而无法打开页面。

搜索引擎蜘蛛更喜欢这样的网址,这样也可以减少蜘蛛的工作量。虽然有些人认为搜索引擎现在已经完全具备抓取和识别动态 URL 的能力,但还是建议您制作静态 URL。使其尽可能静态。

下面我们主要谈谈页面静态的概念,希望对你有所帮助!

什么是 HTML 静态:

常说的页面静态分为两种,一种是伪静态,即url重写,另一种是真静态。

在PHP网站的开发中,为了网站推广和SEO的需要,网站需要对整个站点或部分站点进行静态处理。用PHP生成静态HTML页面的方法有很多,比如使用PHP Templates、缓存等实现页面静态。

PHP静态的简单理解就是让网站生成的页面以静态HTML的形式出现在访问者面前。PHP静态分为纯静态和伪静态。两者的区别在于PHP生成静态页面的处理机制不同。.

PHP 伪静态:一种使用 Apache mod_rewrite 重写 URL 的方法。

静态 HTML 的好处:

一、减轻服务器负担,浏览网页不调用系统数据库。

二、有利于搜索引擎优化SEO,百度和谷歌会优先考虑收录静态页面,不仅速度比收录快,而且充满收录;

三、为了加快页面打开速度,在不连接数据库的情况下,静态页面的打开速度明显高于动态页面;

四、网站更安全,HTML页面不会受到php程序相关漏洞的影响;注意较大的网站基本上都是静态页面,可以减少攻击,防止SQL注入。当数据库发生错误时,不会影响网站的正常访问。

五、数据库出错不会影响网站的正常访问。

最重要的是提高访问速度,减轻服务器负担。当数据量是几万、几十万甚至更多时,你知道哪个更快。而且很容易被搜索引擎找到。生成html文章虽然操作比较麻烦,程序也比较复杂,但是为了更利于搜索,更快更安全,这些牺牲都是值得的。

实现 HTML 静态的策略和示例:

基本方式

file_put_contents() 函数

使用 PHP 内置的缓存机制来实现页面静态 - 输出缓冲。

方法一:使用PHP模板生成静态页面

实现PHP模板的静态化非常方便,比如安装使用PHP Smarty实现网站静态化。

在使用Smarty的情况下,也可以实现静态页面。下面简单说一下使用Smarty时常用的动态阅读。

一般分为这几个步骤:

1、通过URL传递一个参数(ID);

2、然后根据这个ID查询数据库;

3、获取数据后,根据需要修改显示内容;

4、分配要显示的数据;

5、显示模板文件。

Smarty 的静态化过程只需要在上述过程中增加两步即可。

第一:使用ob_start()打开1之前的缓冲区。

第二种:5后使用ob_get_contents()获取内存未输出的内容,然后使用fwrite()将内容写入目标html文件。

根据上面的描述,这个过程是在网站的前台实现的,而内容管理(添加、修改、删除)通常是在后台进行的。)。具体流程如下:添加修改程序后,使用Header()跳转到前台读取,这样页面就可以进行HTML化,生成HTML后再跳转回后台管理端,这两个跳跃过程是看不见的。

方法二:使用PHP文件读写函数生成静态页面

方法三:使用PHP输出控制函数(Output Control)/ob缓存机制生成静态页面

输出控制函数(Output Control)是使用和控制缓存生成静态HTML页面,也使用PHP文件读写函数。

例如某商品的动态详情页地址为:

然后这里我们根据这个地址读取一次详情页的内容,然后保存为静态页。下次有人访问商品详情页的动态地址,我们可以直接输出对应的已经生成的静态内容文件。

PHP生成静态页面示例代码1

PHP生成静态页面示例代码2

我们知道 PHP 用于 网站 开发。一般执行结果直接输出到浏览器。为了使用PHP生成静态页面,需要使用输出控制函数来控制缓存区,从而获取缓存区的内容,然后输出到静态页面。HTML页面文件实现网站静态。

PHP生成静态页面的思路是:先打开缓存,然后输出HTML内容(也可以通过include将HTML内容以文件的形式收录进来),然后获取缓存中的内容,清空缓存,并使用PHP文件读写函数对内容进行读写。缓存的内容被写入静态 HTML 页面文件。

获取输出缓存内容生成静态HTML页面的过程需要用到三个函数:ob_start()、ob_get_contents()、ob_end_clean()。

知识点:

1、ob_start函数一般用于打开缓存。注意在使用ob_start之前不能有任何输出,比如空格、字符等。

2、ob_get_contents 函数主要用于获取缓存中的内容,并将其作为字符串返回。注意该函数必须在ob_end_clean函数之前调用,否则无法获取缓存内容。

3、ob_end_clean函数主要是清除缓存中的内容并关闭缓存,成功返回True,失败返回False

方法四:使用nosql从内存中读取内容(其实这不是静态的而是缓存的);

以memcache为例:

Memcached 是键和值之间的一一对应关系。密钥的默认最大大小不能超过 128 字节。该值的大小默认为1M,所以1M的大小可以满足大部分网页的存储。

以上就是爱站科技频道小编要告诉大家如何用PHP静态制作HTML页面的方法。看完这些内容,相信大家都明白了吧? 查看全部

php如何抓取网页数据(纯静态网站在网站中是怎么进行静态化处理呢?)

随着网站内容和用户访问量的增加,带宽的限制和服务器同时请求的数量也在增加。让爱站技术频道的小编带你看看PHP实现。HTML页面静态方法!

一般会从以下几个方面进行优化

现在很多网站在构建的时候都需要静态处理,为什么网站要静态处理呢?我们都知道纯静态网站就是所有的网页都是独立的html页面。我们访问的时候可以直接读取文件,无需数据处理,访问速度可想而知。而且对于搜索引擎来说也是一种非常友好的方式。

网站 中的纯静态 网站 是如何实现的?

纯静态制作技术需要先对网站的页面进行汇总,分成若干样式,然后将这些页面制作成模板。生成的时候需要先读取源文件,然后生成一个独立的以.html结尾的,所以纯静态网站需要的空间比较大,但其实需要的空间并不多,尤其是中小型——大企业网站,从技术上讲,大网站很难做到全站纯静态,生成时间太长。不过中小网站还是做纯静态比较,有很多好处。

动态 网站 是如何静态处理的?

页面静态是指将动态页面变成html/htm静态页面。动态页面一般都是用asp、php、jsp、.net等编程语言编写的,非常好管理。但是在访问网页时,需要先处理程序,所以访问速度比较慢。静态页面访问速度快,但不易管理。那么动态页面静态可以将两个页面的好处结合在一起。

静态处理给网站带来什么好处?

静态处理的网站比没有静态处理的网站更安全,因为静态网站不是黑客攻击的首选,因为黑客不知道你的后台情况系统,黑客很难从前台的静态页面进行攻击。同时,它也具有一定的稳定性。比如网站的数据库或者程序有问题,不会干扰静态处理的页面,不会因为程序或者数据的影响而无法打开页面。

搜索引擎蜘蛛更喜欢这样的网址,这样也可以减少蜘蛛的工作量。虽然有些人认为搜索引擎现在已经完全具备抓取和识别动态 URL 的能力,但还是建议您制作静态 URL。使其尽可能静态。

下面我们主要谈谈页面静态的概念,希望对你有所帮助!

什么是 HTML 静态:

常说的页面静态分为两种,一种是伪静态,即url重写,另一种是真静态。

在PHP网站的开发中,为了网站推广和SEO的需要,网站需要对整个站点或部分站点进行静态处理。用PHP生成静态HTML页面的方法有很多,比如使用PHP Templates、缓存等实现页面静态。

PHP静态的简单理解就是让网站生成的页面以静态HTML的形式出现在访问者面前。PHP静态分为纯静态和伪静态。两者的区别在于PHP生成静态页面的处理机制不同。.

PHP 伪静态:一种使用 Apache mod_rewrite 重写 URL 的方法。

静态 HTML 的好处:

一、减轻服务器负担,浏览网页不调用系统数据库。

二、有利于搜索引擎优化SEO,百度和谷歌会优先考虑收录静态页面,不仅速度比收录快,而且充满收录;

三、为了加快页面打开速度,在不连接数据库的情况下,静态页面的打开速度明显高于动态页面;

四、网站更安全,HTML页面不会受到php程序相关漏洞的影响;注意较大的网站基本上都是静态页面,可以减少攻击,防止SQL注入。当数据库发生错误时,不会影响网站的正常访问。

五、数据库出错不会影响网站的正常访问。

最重要的是提高访问速度,减轻服务器负担。当数据量是几万、几十万甚至更多时,你知道哪个更快。而且很容易被搜索引擎找到。生成html文章虽然操作比较麻烦,程序也比较复杂,但是为了更利于搜索,更快更安全,这些牺牲都是值得的。

实现 HTML 静态的策略和示例:

基本方式

file_put_contents() 函数

使用 PHP 内置的缓存机制来实现页面静态 - 输出缓冲。

方法一:使用PHP模板生成静态页面

实现PHP模板的静态化非常方便,比如安装使用PHP Smarty实现网站静态化。

在使用Smarty的情况下,也可以实现静态页面。下面简单说一下使用Smarty时常用的动态阅读。

一般分为这几个步骤:

1、通过URL传递一个参数(ID);

2、然后根据这个ID查询数据库;

3、获取数据后,根据需要修改显示内容;

4、分配要显示的数据;

5、显示模板文件。

Smarty 的静态化过程只需要在上述过程中增加两步即可。

第一:使用ob_start()打开1之前的缓冲区。

第二种:5后使用ob_get_contents()获取内存未输出的内容,然后使用fwrite()将内容写入目标html文件。

根据上面的描述,这个过程是在网站的前台实现的,而内容管理(添加、修改、删除)通常是在后台进行的。)。具体流程如下:添加修改程序后,使用Header()跳转到前台读取,这样页面就可以进行HTML化,生成HTML后再跳转回后台管理端,这两个跳跃过程是看不见的。

方法二:使用PHP文件读写函数生成静态页面

方法三:使用PHP输出控制函数(Output Control)/ob缓存机制生成静态页面

输出控制函数(Output Control)是使用和控制缓存生成静态HTML页面,也使用PHP文件读写函数。

例如某商品的动态详情页地址为:

然后这里我们根据这个地址读取一次详情页的内容,然后保存为静态页。下次有人访问商品详情页的动态地址,我们可以直接输出对应的已经生成的静态内容文件。

PHP生成静态页面示例代码1

PHP生成静态页面示例代码2

我们知道 PHP 用于 网站 开发。一般执行结果直接输出到浏览器。为了使用PHP生成静态页面,需要使用输出控制函数来控制缓存区,从而获取缓存区的内容,然后输出到静态页面。HTML页面文件实现网站静态。

PHP生成静态页面的思路是:先打开缓存,然后输出HTML内容(也可以通过include将HTML内容以文件的形式收录进来),然后获取缓存中的内容,清空缓存,并使用PHP文件读写函数对内容进行读写。缓存的内容被写入静态 HTML 页面文件。

获取输出缓存内容生成静态HTML页面的过程需要用到三个函数:ob_start()、ob_get_contents()、ob_end_clean()。

知识点:

1、ob_start函数一般用于打开缓存。注意在使用ob_start之前不能有任何输出,比如空格、字符等。

2、ob_get_contents 函数主要用于获取缓存中的内容,并将其作为字符串返回。注意该函数必须在ob_end_clean函数之前调用,否则无法获取缓存内容。

3、ob_end_clean函数主要是清除缓存中的内容并关闭缓存,成功返回True,失败返回False

方法四:使用nosql从内存中读取内容(其实这不是静态的而是缓存的);

以memcache为例:

Memcached 是键和值之间的一一对应关系。密钥的默认最大大小不能超过 128 字节。该值的大小默认为1M,所以1M的大小可以满足大部分网页的存储。

以上就是爱站科技频道小编要告诉大家如何用PHP静态制作HTML页面的方法。看完这些内容,相信大家都明白了吧?

php如何抓取网页数据( Robots协议目标网址后加/robots.txt的基本语法)

网站优化 • 优采云 发表了文章 • 0 个评论 • 50 次浏览 • 2022-02-15 08:24

Robots协议目标网址后加/robots.txt的基本语法)

import urllib.request

# 私密代理授权的账户

user = "user_name"

# 私密代理授权的密码

passwd = "uesr_password"

# 代理IP地址 比如可以使用百度西刺代理随便选择即可

proxyserver = "177.87.168.97:53281"

# 1. 构建一个密码管理对象,用来保存需要处理的用户名和密码

passwdmgr = urllib.request.HTTPPasswordMgrWithDefaultRealm()

# 2. 添加账户信息,第一个参数realm是与远程服务器相关的域信息,一般没人管它都是写None,后面三个参数分别是 代理服务器、用户名、密码

passwdmgr.add_password(None, proxyserver, user, passwd)

# 3. 构建一个代理基础用户名/密码验证的ProxyBasicAuthHandler处理器对象,参数是创建的密码管理对象

# 注意,这里不再使用普通ProxyHandler类了

proxyauth_handler = urllib.request.ProxyBasicAuthHandler(passwdmgr)

# 4. 通过 build_opener()方法使用这些代理Handler对象,创建自定义opener对象,参数包括构建的 proxy_handler 和 proxyauth_handler

opener = urllib.request.build_opener(proxyauth_handler)

# 5. 构造Request 请求

request = urllib.request.Request("http://bbs.pinggu.org/")

# 6. 使用自定义opener发送请求

response = opener.open(request)

# 7. 打印响应内容

print (response.read())

5.机器人协议

将 /robots.txt 附加到目标 URL,例如:

第一个意思是对于所有爬虫,都不能爬进/? 以 /pop/*.html 开头的路径无法访问匹配 /pop/*.html 的路径。

最后四个用户代理的爬虫不允许访问任何资源。

所以Robots协议的基本语法如下:

二、爬虫抓取网页

1.爬虫的目的

实现浏览器的功能,通过指定的URL直接返回用户需要的数据。

一般步骤:

2.网页分析

获取到对应的内容并分析之后,其实需要处理一段文本,从网页中的代码中提取出你需要的内容。BeautifulSoup 实现了惯用的文档导航、搜索和修改功能。如果lib文件夹中没有BeautifulSoup,可以使用命令行安装。

pip install BeautifulSoup

3.数据提取

# 想要抓取我们需要的东西需要进行定位,寻找到标志

from bs4 import BeautifulSoup

soup = BeautifulSoup('',"html.parser")

tag=soup.meta

# tag的类别

type(tag)

>>> bs4.element.Tag

# tag的name属性

tag.name

>>> 'meta'

# attributes属性

tag.attrs

>>> {'content': 'all', 'name': 'robots'}

# BeautifulSoup属性

type(soup)

>>> bs4.BeautifulSoup

soup.name

>>> '[document]'

# 字符串的提取

markup='房产'

soup=BeautifulSoup(markup,"lxml")

text=soup.b.string

text

>>> '房产'

type(text)

>>> bs4.element.NavigableString

4.BeautifulSoup 应用示例

import requests

from bs4 import BeautifulSoup

url = "http://www.cwestc.com/MroeNews.aspx?gd=2"

html = requests.get(url)

soup = BeautifulSoup(html.text,"lxml")

#通过页面解析得到结构数据进行处理

from bs4 import BeautifulSoup

soup=BeautifulSoup(html.text,"lxml")

#定位

lptable = soup.find('table',width='780')

# 解析

for i in lptable.find_all("td",width="680"):

title = i.b.strong.a.text

href = "http://www.cwestc.com"+i.find('a')['href']

# href = i.find('a')['href']

date = href.split("/")[4]

print (title,href,date)

4.Xpath 应用示例

XPath 是一种用于在 XML 文档中查找信息的语言。XPath 可用于遍历 XML 文档中的元素和属性。XPath 是 W3C XSLT 标准的主要元素,XQuery 和 XPointer 都建立在 XPath 表达式之上。

如何使用四个标签

from lxml import etree

html="""

test

NO.1

NO.2

NO.3

one

two

crossgate

pinggu

"""

#这里使用id属性来定位哪个div和ul被匹配 使用text()获取文本内容

selector=etree.HTML(html)

content=selector.xpath('//div[@id="content"]/ul[@id="ul"]/li/text()')

for i in content:

print (i)

#这里使用//从全文中定位符合条件的a标签,使用“@标签属性”获取a便签的href属性值

con=selector.xpath('//a/@href')

for i in con:

print (i)

#使用绝对路径 #使用相对路径定位 两者效果是一样的

con=selector.xpath('/html/body/div/a/@title')

print (len(con))

print (con[0],con[1])

三、动态网页和静态网页的区别

来源百度:

静态网页的基本概述

静态网页的URL形式通常以.htm、.html、.shtml、.xml等为后缀。静态网页一般是最简单的HTML网页。服务器端和客户端是一样的,没有脚本和小程序,所以不能移动。在 HTML 格式的网页上,也可以出现各种动态效果,比如 .GIF 格式的动画、FLASH、滚动字母等。这些“动态效果”只是视觉上的,与将要实现的动态网页是不同的概念。下面介绍。.

静态网页的特点

动态网页的基本概述

动态网页后缀有.asp、.jsp、.php、.perl、.cgi等形式,并有一个符号——“?” 在动态网页的 URL 中。动态网页与网页上的各种动画和滚动字幕等视觉“动态效果”没有直接关系。动态网页也可以是纯文本内容或收录各种动画。这些只是网页的具体内容。表现形式,无论网页是否具有动态效果,采用动态网站技术生成的网页都称为动态网页。动态网站也可以采用动静结合的原则。适合在使用动态网页的地方使用动态网页。如果需要使用静态网页,可以考虑使用静态网页。

动态网页应具备以下特点:

总结一下:如果页面内容发生变化,URL也会发生变化。基本上,它是一个静态网页,反之亦然是一个动态网页。

四、动态和静态网页的爬取

1.静态网页

import requests

from bs4 import BeautifulSoup

url = "http://www.cwestc.com/MroeNews.aspx?gd=1"

html = requests.get(url)

soup = BeautifulSoup(html.text,"lxml")

soup.text[1900:2000]

import requests

from bs4 import BeautifulSoup

url = "http://www.cwestc.com/MroeNews.aspx?gd=2"

html = requests.get(url)

soup = BeautifulSoup(html.text,"lxml")

soup.text[1900:2000]

总结:以上两个url的区别就在最后一个数字。原页面上下一页的URL和内容同时发生变化。我们判断该页面是静态页面。

2.动态网页

import requests

from bs4 import BeautifulSoup

url = "http://news.cqcoal.com/blank/nl.jsp?tid=238"

html = requests.get(url)

soup = BeautifulSoup(html.text,"lxml")

soup.text

爬取网页,看不到任何信息,证明是动态网页。正确的爬取方法如下。

import urllib

import urllib.request

import requests

url = "http://news.cqcoal.com/manage/ ... ot%3B

post_param = {'pageNum':'1',\

'pageSize':'20',\

'jsonStr':'{"typeid":"238"}'}

return_data = requests.post(url,data =post_param)

content=return_data.text

content

这是文章的介绍,教你如何使用Python快速爬取你需要的数据。更多关于Python爬取数据的信息,请搜索脚本之家之前的文章或继续浏览下方的相关文章,希望以后多多支持脚本之家! 查看全部

php如何抓取网页数据(

Robots协议目标网址后加/robots.txt的基本语法)

import urllib.request

# 私密代理授权的账户

user = "user_name"

# 私密代理授权的密码

passwd = "uesr_password"

# 代理IP地址 比如可以使用百度西刺代理随便选择即可

proxyserver = "177.87.168.97:53281"

# 1. 构建一个密码管理对象,用来保存需要处理的用户名和密码

passwdmgr = urllib.request.HTTPPasswordMgrWithDefaultRealm()

# 2. 添加账户信息,第一个参数realm是与远程服务器相关的域信息,一般没人管它都是写None,后面三个参数分别是 代理服务器、用户名、密码

passwdmgr.add_password(None, proxyserver, user, passwd)

# 3. 构建一个代理基础用户名/密码验证的ProxyBasicAuthHandler处理器对象,参数是创建的密码管理对象

# 注意,这里不再使用普通ProxyHandler类了

proxyauth_handler = urllib.request.ProxyBasicAuthHandler(passwdmgr)

# 4. 通过 build_opener()方法使用这些代理Handler对象,创建自定义opener对象,参数包括构建的 proxy_handler 和 proxyauth_handler

opener = urllib.request.build_opener(proxyauth_handler)

# 5. 构造Request 请求

request = urllib.request.Request("http://bbs.pinggu.org/";)

# 6. 使用自定义opener发送请求

response = opener.open(request)

# 7. 打印响应内容

print (response.read())

5.机器人协议

将 /robots.txt 附加到目标 URL,例如:

第一个意思是对于所有爬虫,都不能爬进/? 以 /pop/*.html 开头的路径无法访问匹配 /pop/*.html 的路径。

最后四个用户代理的爬虫不允许访问任何资源。

所以Robots协议的基本语法如下:

二、爬虫抓取网页

1.爬虫的目的

实现浏览器的功能,通过指定的URL直接返回用户需要的数据。

一般步骤:

2.网页分析

获取到对应的内容并分析之后,其实需要处理一段文本,从网页中的代码中提取出你需要的内容。BeautifulSoup 实现了惯用的文档导航、搜索和修改功能。如果lib文件夹中没有BeautifulSoup,可以使用命令行安装。

pip install BeautifulSoup

3.数据提取

# 想要抓取我们需要的东西需要进行定位,寻找到标志

from bs4 import BeautifulSoup

soup = BeautifulSoup('',"html.parser")

tag=soup.meta

# tag的类别

type(tag)

>>> bs4.element.Tag

# tag的name属性

tag.name

>>> 'meta'

# attributes属性

tag.attrs

>>> {'content': 'all', 'name': 'robots'}

# BeautifulSoup属性

type(soup)

>>> bs4.BeautifulSoup

soup.name

>>> '[document]'

# 字符串的提取

markup='房产'

soup=BeautifulSoup(markup,"lxml")

text=soup.b.string

text

>>> '房产'

type(text)

>>> bs4.element.NavigableString

4.BeautifulSoup 应用示例

import requests

from bs4 import BeautifulSoup

url = "http://www.cwestc.com/MroeNews.aspx?gd=2"

html = requests.get(url)

soup = BeautifulSoup(html.text,"lxml")

#通过页面解析得到结构数据进行处理

from bs4 import BeautifulSoup

soup=BeautifulSoup(html.text,"lxml")

#定位

lptable = soup.find('table',width='780')

# 解析

for i in lptable.find_all("td",width="680"):

title = i.b.strong.a.text

href = "http://www.cwestc.com"+i.find('a')['href']

# href = i.find('a')['href']

date = href.split("/")[4]

print (title,href,date)

4.Xpath 应用示例

XPath 是一种用于在 XML 文档中查找信息的语言。XPath 可用于遍历 XML 文档中的元素和属性。XPath 是 W3C XSLT 标准的主要元素,XQuery 和 XPointer 都建立在 XPath 表达式之上。

如何使用四个标签

from lxml import etree

html="""

test

NO.1

NO.2

NO.3

one

two

crossgate

pinggu

"""

#这里使用id属性来定位哪个div和ul被匹配 使用text()获取文本内容

selector=etree.HTML(html)

content=selector.xpath('//div[@id="content"]/ul[@id="ul"]/li/text()')

for i in content:

print (i)

#这里使用//从全文中定位符合条件的a标签,使用“@标签属性”获取a便签的href属性值

con=selector.xpath('//a/@href')

for i in con:

print (i)

#使用绝对路径 #使用相对路径定位 两者效果是一样的

con=selector.xpath('/html/body/div/a/@title')

print (len(con))

print (con[0],con[1])

三、动态网页和静态网页的区别

来源百度:

静态网页的基本概述

静态网页的URL形式通常以.htm、.html、.shtml、.xml等为后缀。静态网页一般是最简单的HTML网页。服务器端和客户端是一样的,没有脚本和小程序,所以不能移动。在 HTML 格式的网页上,也可以出现各种动态效果,比如 .GIF 格式的动画、FLASH、滚动字母等。这些“动态效果”只是视觉上的,与将要实现的动态网页是不同的概念。下面介绍。.

静态网页的特点

动态网页的基本概述

动态网页后缀有.asp、.jsp、.php、.perl、.cgi等形式,并有一个符号——“?” 在动态网页的 URL 中。动态网页与网页上的各种动画和滚动字幕等视觉“动态效果”没有直接关系。动态网页也可以是纯文本内容或收录各种动画。这些只是网页的具体内容。表现形式,无论网页是否具有动态效果,采用动态网站技术生成的网页都称为动态网页。动态网站也可以采用动静结合的原则。适合在使用动态网页的地方使用动态网页。如果需要使用静态网页,可以考虑使用静态网页。

动态网页应具备以下特点:

总结一下:如果页面内容发生变化,URL也会发生变化。基本上,它是一个静态网页,反之亦然是一个动态网页。

四、动态和静态网页的爬取

1.静态网页

import requests

from bs4 import BeautifulSoup

url = "http://www.cwestc.com/MroeNews.aspx?gd=1"

html = requests.get(url)

soup = BeautifulSoup(html.text,"lxml")

soup.text[1900:2000]

import requests

from bs4 import BeautifulSoup

url = "http://www.cwestc.com/MroeNews.aspx?gd=2"

html = requests.get(url)

soup = BeautifulSoup(html.text,"lxml")

soup.text[1900:2000]

总结:以上两个url的区别就在最后一个数字。原页面上下一页的URL和内容同时发生变化。我们判断该页面是静态页面。

2.动态网页

import requests

from bs4 import BeautifulSoup

url = "http://news.cqcoal.com/blank/nl.jsp?tid=238"

html = requests.get(url)

soup = BeautifulSoup(html.text,"lxml")

soup.text

爬取网页,看不到任何信息,证明是动态网页。正确的爬取方法如下。

import urllib

import urllib.request

import requests

url = "http://news.cqcoal.com/manage/ ... ot%3B

post_param = {'pageNum':'1',\

'pageSize':'20',\

'jsonStr':'{"typeid":"238"}'}

return_data = requests.post(url,data =post_param)

content=return_data.text

content

这是文章的介绍,教你如何使用Python快速爬取你需要的数据。更多关于Python爬取数据的信息,请搜索脚本之家之前的文章或继续浏览下方的相关文章,希望以后多多支持脚本之家!

php如何抓取网页数据(安装python运行pipinstallrequests抓取网页完成必要工具安装后织梦5.7采集教程)

网站优化 • 优采云 发表了文章 • 0 个评论 • 121 次浏览 • 2022-02-15 08:21

各种搜索引擎,小到日常数据采集,都离不开网络爬虫织梦5.7采集教程。爬虫的基本原理很简单。它遍历网络中的网页并抓取感兴趣的数据内容。本期文章将介绍如何编写一个网络爬虫从零开始爬取数据,然后逐步完善爬虫的爬取功能。

工具安装