js 爬虫抓取网页数据

js 爬虫抓取网页数据( 如何轻松爬取数据学习Python包并完成根本的爬虫进程)

网站优化 • 优采云 发表了文章 • 0 个评论 • 94 次浏览 • 2022-02-11 11:27

如何轻松爬取数据学习Python包并完成根本的爬虫进程)

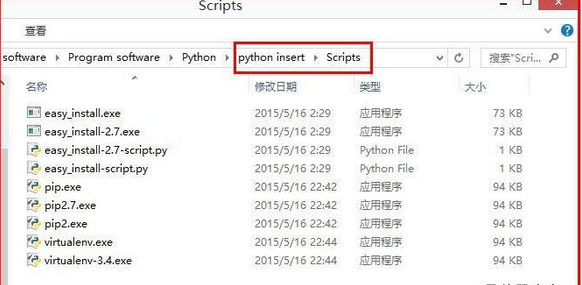

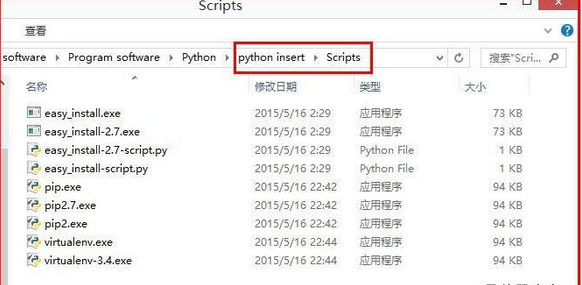

<p>使用Python语言轻松爬取数据对于小白来说,爬取可能是一件非常复杂的事情,技术门槛很高。比如有人认为学习爬虫一定要精通Python,然后哼哼哼系统地学习Python的每一个知识点。有些人认为首先需要掌握网页的知识。HTML和CSS的结果还在前端的坑里。让我告诉你如何轻松爬取数据以学习Python包并完成基本的爬取过程。大部分爬虫按ldquo发送请求获取页面解析页面提取并存储内容rdquo。这实际上是一个模仿使用浏览器获取网页信息的过程的过程。Python中有很多爬虫相关的包,比如urllibrequestsbs4scrapypyspider等。@网站转到网页 Xpath用于解析网页,方便提取数据。如果你用过 BeautifulSoup,你会发现 Xpath 会为你省去很多麻烦。层层复习元素代码的任务都省略了,所以基本套路几乎就是普通的静态 查看全部

js 爬虫抓取网页数据(

如何轻松爬取数据学习Python包并完成根本的爬虫进程)

<p>使用Python语言轻松爬取数据对于小白来说,爬取可能是一件非常复杂的事情,技术门槛很高。比如有人认为学习爬虫一定要精通Python,然后哼哼哼系统地学习Python的每一个知识点。有些人认为首先需要掌握网页的知识。HTML和CSS的结果还在前端的坑里。让我告诉你如何轻松爬取数据以学习Python包并完成基本的爬取过程。大部分爬虫按ldquo发送请求获取页面解析页面提取并存储内容rdquo。这实际上是一个模仿使用浏览器获取网页信息的过程的过程。Python中有很多爬虫相关的包,比如urllibrequestsbs4scrapypyspider等。@网站转到网页 Xpath用于解析网页,方便提取数据。如果你用过 BeautifulSoup,你会发现 Xpath 会为你省去很多麻烦。层层复习元素代码的任务都省略了,所以基本套路几乎就是普通的静态

js 爬虫抓取网页数据(福布斯确认Google所作的远远超过对各种链接的简单分析)

网站优化 • 优采云 发表了文章 • 0 个评论 • 60 次浏览 • 2022-02-09 10:06

谷歌的搜索爬虫能够读取 JavaScript 代码已经有很长时间了,但多年来一直不清楚谷歌的爬虫是真的明白它在爬什么,还是只是在解释各种链接执行死板的搜索。周五,谷歌发言人向福布斯证实,谷歌所做的远不止是对 js 代码的简单分析。“谷歌能够分析和理解一些JavaScript,”发言人说。

谷歌的演示让我们意识到,它的爬虫可能不仅仅是获取页面的相关链接,还可以与人类等程序进行交互——发现像 Bing 这样的搜索引擎无法发现的在线世界。而这意味着谷歌重新定义了搜索引擎。谷歌搜索结果中只有少数几个js代码,而谷歌预留了很多这段js代码的解释功能。例如,Google 的 SiteSearch 上的文档显示它无法使用 js 代码索引内容。一本关于索引的介绍性教科书指出,它(谷歌的爬虫)“不能处理富媒体内容或动态网页”。仔细检查服务器日志中的记录表明,谷歌现在正在索引不直接收录在 js 代码中的链接。谷歌'

独立搜索引擎公司 Wowd 的 CEO Mark Drummond(我们今年早些时候在我们的杂志上采访过他)在一封电子邮件中告诉我们,理解 js 代码“是一个非常深刻、困难和经典的计算科学问题。” 他解释说,谷歌的努力在于它能够找出页面中的 js 代码是否已经停止运行。“停滞的问题是无法确定的,”他说,并说没有已知的算法可以告诉我们是否有任何程序在任何时间点陷入无限循环,并且已经在数学上证明了这一点。Drummond 自己的公司手动搜索其索引并标记是否可以简化复杂问题,同时还确定一个网络程序是否正在向另一个网络程序发出数据请求。也许,

另一位接近 Google 的搜索引擎人士同意 Drummond 关于理解 js 代码复杂性的观点。他认为用一个程序分析另一个程序是非常困难的,执行js代码几乎是现阶段所能做的极限。

而谷歌6月份发布的改进型搜索算法(即Caffeine)似乎可以看懂部分js代码。如果这是真的,那么谷歌的工程师已经教会了它的爬虫如何执行部分 js 代码。多么大的突破! 查看全部

js 爬虫抓取网页数据(福布斯确认Google所作的远远超过对各种链接的简单分析)

谷歌的搜索爬虫能够读取 JavaScript 代码已经有很长时间了,但多年来一直不清楚谷歌的爬虫是真的明白它在爬什么,还是只是在解释各种链接执行死板的搜索。周五,谷歌发言人向福布斯证实,谷歌所做的远不止是对 js 代码的简单分析。“谷歌能够分析和理解一些JavaScript,”发言人说。

谷歌的演示让我们意识到,它的爬虫可能不仅仅是获取页面的相关链接,还可以与人类等程序进行交互——发现像 Bing 这样的搜索引擎无法发现的在线世界。而这意味着谷歌重新定义了搜索引擎。谷歌搜索结果中只有少数几个js代码,而谷歌预留了很多这段js代码的解释功能。例如,Google 的 SiteSearch 上的文档显示它无法使用 js 代码索引内容。一本关于索引的介绍性教科书指出,它(谷歌的爬虫)“不能处理富媒体内容或动态网页”。仔细检查服务器日志中的记录表明,谷歌现在正在索引不直接收录在 js 代码中的链接。谷歌'

独立搜索引擎公司 Wowd 的 CEO Mark Drummond(我们今年早些时候在我们的杂志上采访过他)在一封电子邮件中告诉我们,理解 js 代码“是一个非常深刻、困难和经典的计算科学问题。” 他解释说,谷歌的努力在于它能够找出页面中的 js 代码是否已经停止运行。“停滞的问题是无法确定的,”他说,并说没有已知的算法可以告诉我们是否有任何程序在任何时间点陷入无限循环,并且已经在数学上证明了这一点。Drummond 自己的公司手动搜索其索引并标记是否可以简化复杂问题,同时还确定一个网络程序是否正在向另一个网络程序发出数据请求。也许,

另一位接近 Google 的搜索引擎人士同意 Drummond 关于理解 js 代码复杂性的观点。他认为用一个程序分析另一个程序是非常困难的,执行js代码几乎是现阶段所能做的极限。

而谷歌6月份发布的改进型搜索算法(即Caffeine)似乎可以看懂部分js代码。如果这是真的,那么谷歌的工程师已经教会了它的爬虫如何执行部分 js 代码。多么大的突破!

js 爬虫抓取网页数据(谷歌能DOM是什么?Google能读取动态生成的内容 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 375 次浏览 • 2022-02-09 10:02

)

(点击上方公众号快速关注)

编译:伯乐在线/刘建超-Jc

以下是我们从测试 Google 的爬虫如何抓取 JavaScript 中学到的东西。

认为 Google 无法处理 JavaScript?再想一想。Audette Audette 分享了一系列测试的结果,他和他的同事测试了 Google 和 收录 抓取的 JavaScript 功能类型。

长话短说

1. 我们进行了一系列测试,并确认 Google 可以通过多种方式执行和 收录 JavaScript。我们还确认 Google 可以渲染整个页面并读取 DOM,从而收录动态生成内容。

2. DOM 中的 SEO 信号(页面标题、元描述、规范标签、元机器人标签等)都得到了处理。动态插入 DOM 的内容也可以被爬取和收录。此外,在某些情况下,DOM 甚至可能优先于 HTML 源语句。虽然这需要更多的工作,但这是我们完成的几个测试之一。

简介:Google 执行 JavaScript 并读取 DOM

早在 2008 年,Google 就成功抓取了 JavaScript,但可能只是以某种方式。

而今天,很明显,Google 不仅能够计算出他们抓取的 JavaScript 类型和 收录,而且在渲染整个网页方面取得了重大进展(尤其是在过去 12 到 18 个月内)。

在 Merkle,我们的 SEO 技术团队希望更好地了解 Google 爬虫可以抓取哪些类型的 JavaScript 事件以及 收录。经过研究,我们发现了令人瞠目结舌的结果,证实 Google 不仅可以执行各种 JavaScript 事件,还可以执行 收录 动态生成的内容。怎么做?Google 可以读取 DOM。

什么是 DOM?

许多从事 SEO 的人不了解文档对象模型 (DOM) 是什么。

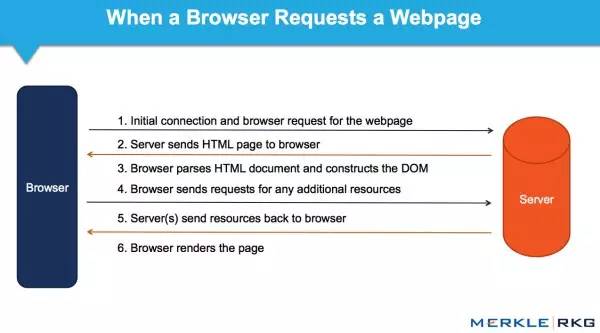

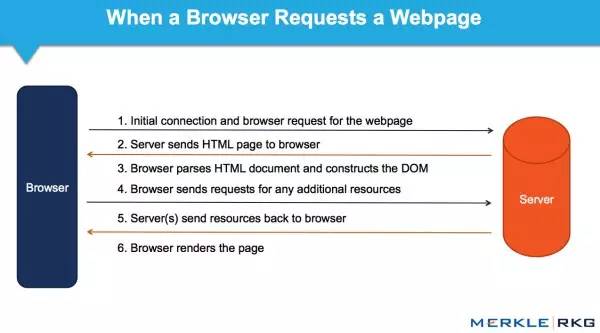

当浏览器请求一个页面时会发生什么,以及 DOM 是如何参与的。

在 Web 浏览器中使用时,DOM 本质上是一个应用程序接口或 API,用于标记和结构化数据(例如 HTML 和 XML)。此界面允许 Web 浏览器将它们组合成文档。

DOM 还定义了如何访问和操作结构。尽管 DOM 是一种独立于语言的 API(不依赖于特定的编程语言或库),但它通常用于 JavaScript 和 Web 应用程序中的动态内容。

DOM 表示将网页连接到编程语言的接口或“桥梁”。解析 HTML 和执行 JavaScript 的结果就是 DOM。网页的内容不是(不仅是)源代码,它是 DOM。这使得它非常重要。

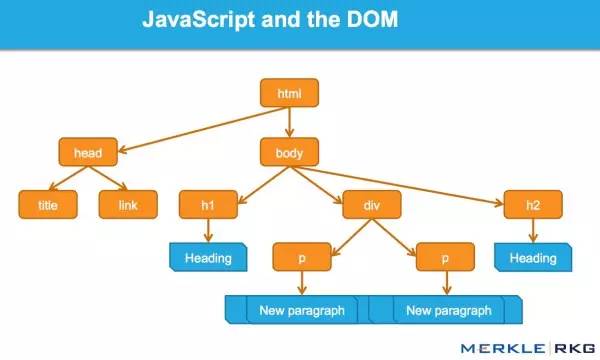

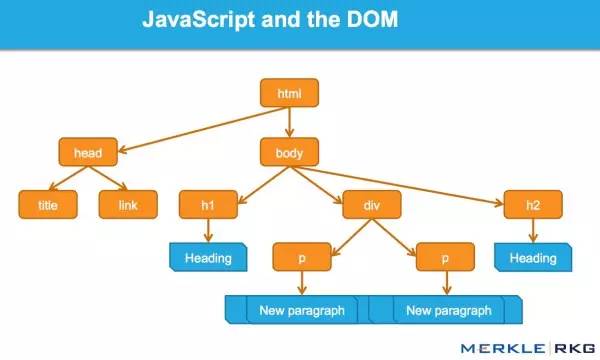

JavaScript 如何通过 DOM 接口工作。

我们很高兴地发现 Google 可以读取 DOM 并解析信号并动态插入内容,例如标题标签、页面文本、头部标签和元注释(例如 rel=canonical)。在那里阅读完整的细节。

这一系列的测试和结果

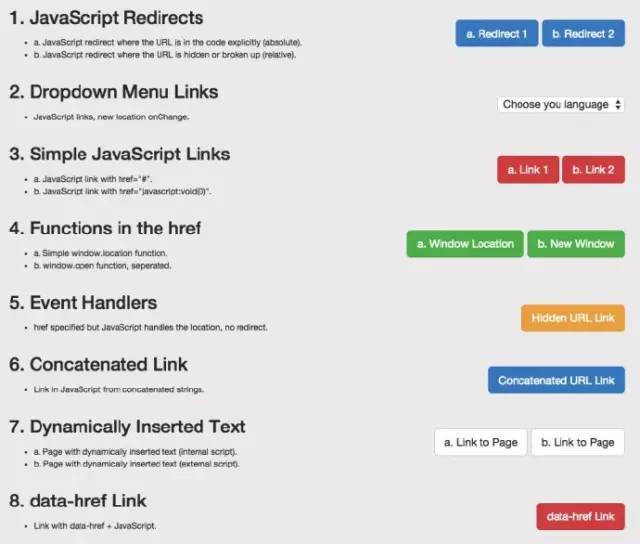

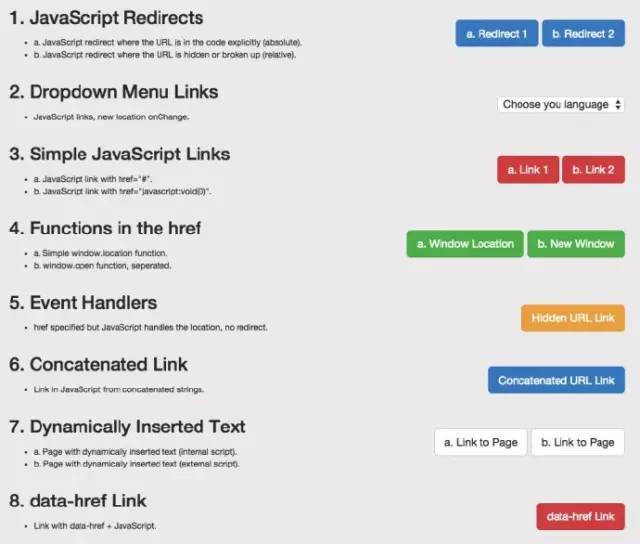

因为我们想知道会抓取哪些 JavaScript 功能以及 收录,所以我们单独针对 Google 抓取工具创建了一系列测试。确保通过创建控件独立理解 URL 活动。下面,让我们详细分解一些有趣的测试结果。它们分为5类:

JavaScript 重定向

JavaScript 链接

动态插入内容

动态插入元数据和页面元素

rel = "nofollow" 的一个重要示例

示例:用于测试 Google 抓取工具理解 JavaScript 的能力的页面。

1. JavaScript 重定向

我们首先测试了常见的 JavaScript 重定向,用不同的方式表达的 URL 会产生什么结果?我们为两个测试选择了 window.location 对象:测试 A 使用绝对路径 URL 调用 window.location,而测试 B 使用相对路径。

结果:重定向很快被谷歌跟踪。从 收录 开始,它们被解释为 301 - 最终状态 URL,而不是 Google 收录 中的重定向 URL。

在随后的测试中,我们执行了 JavaScript 重定向到同一站点上的新页面,在权威页面上具有完全相同的内容。而原创 URL 是 Google 的热门查询的首页。

结果:果然,重定向被谷歌跟踪了,原来的页面不是收录。而新的 URL 是 收录 并立即在同一个查询页面中排名相同的位置。这让我们感到惊讶,因为从排名的角度来看,它似乎表明 JavaScript 重定向的行为(有时)很像永久 301 重定向。

下次您的客户想要为他们的 网站 完成 JavaScript 重定向移动时,您可能不需要回答,或者回答:“请不要”。因为这似乎有转移排名信号的关系。支持这一结论的是对谷歌指南的引用:

使用 JavaScript 重定向用户可能是一种合法的做法。例如,如果您将登录用户重定向到内部页面,您可以使用 JavaScript 执行此操作。在检查 JavaScript 或其他重定向方法时,请确保您的网站遵循我们的指南并考虑其意图。请记住,301 重定向到您的 网站 是最好的,但如果您无权访问您的 网站 服务器,则可以使用 JavaScript 重定向。

2. JavaScript 链接

我们用不同的编码测试了不同类型的 JS 链接。

我们测试下拉菜单的链接。搜索引擎历来无法跟踪此类链接。我们想确定是否会跟踪 onchange 事件处理程序。重要的是,这只是我们需要的特定执行类型:其他更改的效果,而不是上面 JavaScript 重定向的强制操作。

示例:Google Work 页面的语言选择下拉菜单。

结果:链接被完全爬取并被关注。

我们还测试了常见的 JavaScript 链接。以下是最常见的 JavaScript 链接类型,而传统的 SEO 建议使用纯文本。这些测试包括 JavaScript 链接代码:

结果:链接被完全爬取并被关注。

我们的下一个测试是进一步测试事件处理程序,例如上面的 onchange 测试。具体来说,我们希望利用鼠标移动事件处理程序,然后隐藏 URL 变量,该变量仅在事件处理程序(本例中的 onmousedown 和 onmouseout)被触发时执行。

结果:链接被完全爬取并被关注。

构建链接:我们知道 Google 可以执行 JavaScript,但希望确保他们可以读取代码中的变量。所以在这个测试中,我们连接可以构造 URL 字符串的字符。

结果:链接被完全爬取并被关注。

3. 动态插入内容

显然,这些是要点:文本、图像、链接和导航的动态插入。高质量的文本内容对于搜索引擎理解网页主题和内容至关重要。在这个充满活力的网站时代,它的重要性毋庸置疑。

这些测试旨在检查在两种不同场景中动态插入文本的结果。

1. 测试搜索引擎是否可以从页面的 HTML 源中动态计算插入的文本。

2. 测试搜索引擎是否可以计算来自页面 HTML 源外部(在外部 JavaScript 文件中)的动态插入文本。

结果:在这两种情况下,文本都被爬取和 收录,并且页面根据该内容进行排名。凉爽的!

为了了解更多信息,我们测试了一个用 JavaScript 编写的客户端全局导航,其中收录通过 document.writeIn 函数插入的链接,并确定它们已被完全抓取和跟踪。需要注意的是:Google 可以解释使用 AngularJS 框架和 HTML5 History API (pushState) 构建的 网站,可以渲染和 收录 它,并像传统的静态网页一样对其进行排名。这就是为什么不禁止 Google 的爬虫获取外部文件和 JavaScript 很重要,这可能也是 Google 将其从启用 Ajax 的 SEO 指南中删除的原因。当您可以简单地呈现整个页面时,谁需要 HTML 快照?

经过测试,发现无论是什么类型的内容,都是一样的结果。例如,图像被抓取并将 收录 加载到 DOM 中。我们甚至通过动态生成结构化数据并将其插入到 DOM 中做了一个制作面包屑(breadcrumbs)的测试。结果呢?成功插入的面包屑出现在搜索结果(搜索引擎结果页面)中。

值得注意的是,Google 现在建议对结构化数据使用 JSON-LD 标记。我相信将来会有更多基于此的。

4. 动态插入元数据和页面元素

我们将各种 SEO 关键标签动态插入到 DOM 中:

结果:在所有情况下,标签都可以被抓取并表现得像 HTML 源代码中的元素。

一个有趣的补充实验可以帮助我们理解优先级。当有相互冲突的信号时,哪一个获胜?如果源代码中有 noindex、nofollow 标签,而 DOM 中有 noindex、follow 标签,会发生什么?在此协议中,HTTP x-robots 响应标头作为另一个变量的行为如何?这将是未来综合测试的一部分。但是,我们的测试表明,当发生冲突时,Google 会忽略源代码中的标签,转而使用 DOM。

5. rel="nofollow" 的一个重要示例

我们想测试 Google 如何处理出现在源代码和 DOM 中的链接级别的 nofollow 属性。因此,我们创建了一个没有应用 nofollow 的控件。

对于 nofollow,我们分别测试源代码与 DOM 生成的注释。

源代码中的 nofollow 可以按我们预期的方式工作(没有链接)。DOM 中的 nofollow 不起作用(链接被跟踪,页面为 收录)。为什么?因为修改 DOM 中的 href 元素为时已晚:Google 已准备好抓取链接并将 URL 排队,然后执行添加 rel=”nofollow” 的 JavaScript 函数。但是,如果将带有 href="nofollow" 的 a 元素插入到 DOM 中,则会跟踪 nofollow 和链接,因为它们是同时插入的。

结果

从历史上看,各种 SEO 建议一直尽可能关注“纯文本”内容。动态生成的内容、AJAX 和 JavaScript 链接可能会损害主要搜索引擎的 SEO。显然,这对谷歌来说不再是问题。JavaScript 链接的行为类似于普通的 HTML 链接(这只是表面,我们不知道幕后发生了什么)。

对于SEO,对以上基本概念和谷歌技术不了解的人,应该好好研究学习,赶上现在的技术。如果你不考虑 DOM,你可能会失去一半的份额。

并非本文中表达的所有观点均由 Search Engine Land(搜索引擎 网站)提供,部分观点由客座作者提供。所有作者的名单。

认为这篇文章对您有帮助吗?请与更多人分享

关注“前端大全”提升前端技能

查看全部

js 爬虫抓取网页数据(谷歌能DOM是什么?Google能读取动态生成的内容

)

(点击上方公众号快速关注)

编译:伯乐在线/刘建超-Jc

以下是我们从测试 Google 的爬虫如何抓取 JavaScript 中学到的东西。

认为 Google 无法处理 JavaScript?再想一想。Audette Audette 分享了一系列测试的结果,他和他的同事测试了 Google 和 收录 抓取的 JavaScript 功能类型。

长话短说

1. 我们进行了一系列测试,并确认 Google 可以通过多种方式执行和 收录 JavaScript。我们还确认 Google 可以渲染整个页面并读取 DOM,从而收录动态生成内容。

2. DOM 中的 SEO 信号(页面标题、元描述、规范标签、元机器人标签等)都得到了处理。动态插入 DOM 的内容也可以被爬取和收录。此外,在某些情况下,DOM 甚至可能优先于 HTML 源语句。虽然这需要更多的工作,但这是我们完成的几个测试之一。

简介:Google 执行 JavaScript 并读取 DOM

早在 2008 年,Google 就成功抓取了 JavaScript,但可能只是以某种方式。

而今天,很明显,Google 不仅能够计算出他们抓取的 JavaScript 类型和 收录,而且在渲染整个网页方面取得了重大进展(尤其是在过去 12 到 18 个月内)。

在 Merkle,我们的 SEO 技术团队希望更好地了解 Google 爬虫可以抓取哪些类型的 JavaScript 事件以及 收录。经过研究,我们发现了令人瞠目结舌的结果,证实 Google 不仅可以执行各种 JavaScript 事件,还可以执行 收录 动态生成的内容。怎么做?Google 可以读取 DOM。

什么是 DOM?

许多从事 SEO 的人不了解文档对象模型 (DOM) 是什么。

当浏览器请求一个页面时会发生什么,以及 DOM 是如何参与的。

在 Web 浏览器中使用时,DOM 本质上是一个应用程序接口或 API,用于标记和结构化数据(例如 HTML 和 XML)。此界面允许 Web 浏览器将它们组合成文档。

DOM 还定义了如何访问和操作结构。尽管 DOM 是一种独立于语言的 API(不依赖于特定的编程语言或库),但它通常用于 JavaScript 和 Web 应用程序中的动态内容。

DOM 表示将网页连接到编程语言的接口或“桥梁”。解析 HTML 和执行 JavaScript 的结果就是 DOM。网页的内容不是(不仅是)源代码,它是 DOM。这使得它非常重要。

JavaScript 如何通过 DOM 接口工作。

我们很高兴地发现 Google 可以读取 DOM 并解析信号并动态插入内容,例如标题标签、页面文本、头部标签和元注释(例如 rel=canonical)。在那里阅读完整的细节。

这一系列的测试和结果

因为我们想知道会抓取哪些 JavaScript 功能以及 收录,所以我们单独针对 Google 抓取工具创建了一系列测试。确保通过创建控件独立理解 URL 活动。下面,让我们详细分解一些有趣的测试结果。它们分为5类:

JavaScript 重定向

JavaScript 链接

动态插入内容

动态插入元数据和页面元素

rel = "nofollow" 的一个重要示例

示例:用于测试 Google 抓取工具理解 JavaScript 的能力的页面。

1. JavaScript 重定向

我们首先测试了常见的 JavaScript 重定向,用不同的方式表达的 URL 会产生什么结果?我们为两个测试选择了 window.location 对象:测试 A 使用绝对路径 URL 调用 window.location,而测试 B 使用相对路径。

结果:重定向很快被谷歌跟踪。从 收录 开始,它们被解释为 301 - 最终状态 URL,而不是 Google 收录 中的重定向 URL。

在随后的测试中,我们执行了 JavaScript 重定向到同一站点上的新页面,在权威页面上具有完全相同的内容。而原创 URL 是 Google 的热门查询的首页。

结果:果然,重定向被谷歌跟踪了,原来的页面不是收录。而新的 URL 是 收录 并立即在同一个查询页面中排名相同的位置。这让我们感到惊讶,因为从排名的角度来看,它似乎表明 JavaScript 重定向的行为(有时)很像永久 301 重定向。

下次您的客户想要为他们的 网站 完成 JavaScript 重定向移动时,您可能不需要回答,或者回答:“请不要”。因为这似乎有转移排名信号的关系。支持这一结论的是对谷歌指南的引用:

使用 JavaScript 重定向用户可能是一种合法的做法。例如,如果您将登录用户重定向到内部页面,您可以使用 JavaScript 执行此操作。在检查 JavaScript 或其他重定向方法时,请确保您的网站遵循我们的指南并考虑其意图。请记住,301 重定向到您的 网站 是最好的,但如果您无权访问您的 网站 服务器,则可以使用 JavaScript 重定向。

2. JavaScript 链接

我们用不同的编码测试了不同类型的 JS 链接。

我们测试下拉菜单的链接。搜索引擎历来无法跟踪此类链接。我们想确定是否会跟踪 onchange 事件处理程序。重要的是,这只是我们需要的特定执行类型:其他更改的效果,而不是上面 JavaScript 重定向的强制操作。

示例:Google Work 页面的语言选择下拉菜单。

结果:链接被完全爬取并被关注。

我们还测试了常见的 JavaScript 链接。以下是最常见的 JavaScript 链接类型,而传统的 SEO 建议使用纯文本。这些测试包括 JavaScript 链接代码:

结果:链接被完全爬取并被关注。

我们的下一个测试是进一步测试事件处理程序,例如上面的 onchange 测试。具体来说,我们希望利用鼠标移动事件处理程序,然后隐藏 URL 变量,该变量仅在事件处理程序(本例中的 onmousedown 和 onmouseout)被触发时执行。

结果:链接被完全爬取并被关注。

构建链接:我们知道 Google 可以执行 JavaScript,但希望确保他们可以读取代码中的变量。所以在这个测试中,我们连接可以构造 URL 字符串的字符。

结果:链接被完全爬取并被关注。

3. 动态插入内容

显然,这些是要点:文本、图像、链接和导航的动态插入。高质量的文本内容对于搜索引擎理解网页主题和内容至关重要。在这个充满活力的网站时代,它的重要性毋庸置疑。

这些测试旨在检查在两种不同场景中动态插入文本的结果。

1. 测试搜索引擎是否可以从页面的 HTML 源中动态计算插入的文本。

2. 测试搜索引擎是否可以计算来自页面 HTML 源外部(在外部 JavaScript 文件中)的动态插入文本。

结果:在这两种情况下,文本都被爬取和 收录,并且页面根据该内容进行排名。凉爽的!

为了了解更多信息,我们测试了一个用 JavaScript 编写的客户端全局导航,其中收录通过 document.writeIn 函数插入的链接,并确定它们已被完全抓取和跟踪。需要注意的是:Google 可以解释使用 AngularJS 框架和 HTML5 History API (pushState) 构建的 网站,可以渲染和 收录 它,并像传统的静态网页一样对其进行排名。这就是为什么不禁止 Google 的爬虫获取外部文件和 JavaScript 很重要,这可能也是 Google 将其从启用 Ajax 的 SEO 指南中删除的原因。当您可以简单地呈现整个页面时,谁需要 HTML 快照?

经过测试,发现无论是什么类型的内容,都是一样的结果。例如,图像被抓取并将 收录 加载到 DOM 中。我们甚至通过动态生成结构化数据并将其插入到 DOM 中做了一个制作面包屑(breadcrumbs)的测试。结果呢?成功插入的面包屑出现在搜索结果(搜索引擎结果页面)中。

值得注意的是,Google 现在建议对结构化数据使用 JSON-LD 标记。我相信将来会有更多基于此的。

4. 动态插入元数据和页面元素

我们将各种 SEO 关键标签动态插入到 DOM 中:

结果:在所有情况下,标签都可以被抓取并表现得像 HTML 源代码中的元素。

一个有趣的补充实验可以帮助我们理解优先级。当有相互冲突的信号时,哪一个获胜?如果源代码中有 noindex、nofollow 标签,而 DOM 中有 noindex、follow 标签,会发生什么?在此协议中,HTTP x-robots 响应标头作为另一个变量的行为如何?这将是未来综合测试的一部分。但是,我们的测试表明,当发生冲突时,Google 会忽略源代码中的标签,转而使用 DOM。

5. rel="nofollow" 的一个重要示例

我们想测试 Google 如何处理出现在源代码和 DOM 中的链接级别的 nofollow 属性。因此,我们创建了一个没有应用 nofollow 的控件。

对于 nofollow,我们分别测试源代码与 DOM 生成的注释。

源代码中的 nofollow 可以按我们预期的方式工作(没有链接)。DOM 中的 nofollow 不起作用(链接被跟踪,页面为 收录)。为什么?因为修改 DOM 中的 href 元素为时已晚:Google 已准备好抓取链接并将 URL 排队,然后执行添加 rel=”nofollow” 的 JavaScript 函数。但是,如果将带有 href="nofollow" 的 a 元素插入到 DOM 中,则会跟踪 nofollow 和链接,因为它们是同时插入的。

结果

从历史上看,各种 SEO 建议一直尽可能关注“纯文本”内容。动态生成的内容、AJAX 和 JavaScript 链接可能会损害主要搜索引擎的 SEO。显然,这对谷歌来说不再是问题。JavaScript 链接的行为类似于普通的 HTML 链接(这只是表面,我们不知道幕后发生了什么)。

对于SEO,对以上基本概念和谷歌技术不了解的人,应该好好研究学习,赶上现在的技术。如果你不考虑 DOM,你可能会失去一半的份额。

并非本文中表达的所有观点均由 Search Engine Land(搜索引擎 网站)提供,部分观点由客座作者提供。所有作者的名单。

认为这篇文章对您有帮助吗?请与更多人分享

关注“前端大全”提升前端技能

js 爬虫抓取网页数据(js爬虫抓取网页数据源码分析难度相对高些-苏州安嘉)

网站优化 • 优采云 发表了文章 • 0 个评论 • 53 次浏览 • 2022-02-09 00:01

js爬虫抓取网页数据,主要分为两部分,一部分是上网页,另一部分是爬数据库。常见的requests库中有selenium模块,但是selenium模块的源码分析难度相对高些,我们用的urllib模块,urllib2就是selenium的selenium模块就是selenium爬虫常用的三种网络请求库:selenium.webdriver.chrome(webdriver类的子类)urllib2.http.forward(url,http头)以下我们只介绍forward请求一般的请求步骤:打开浏览器——获取本地路径(项目文件夹或python文件)——获取页面内容(项目文件夹或python文件)——下载并解压文件——代码存入数据库某个文件中——获取页面内容存入文件xx(项目文件夹或python文件)。

1、打开浏览器获取本地路径(项目文件夹或python文件)在python2下,

2、使用浏览器打开正常模式找到我们需要抓取的页面,

3、获取页面内容(项目文件夹或python文件)importhttplib2fromurllibimportrequestimportxxfromopenerimportbeautifulsoupfromurllib。requestimportrequesturl=''url=''foriinrange(1,1000。

0):urlopen=request.urlopen(url)printurlopen.read()printrequest.urlopen(url)当然不限于这三种方法,以后我们都会介绍到对urllib2的熟悉,它一个库拥有三种方法:urlopen、urlopenxml()、open(),分别用来解析网页内容,调用get函数。我们通过这三种方法抓取网页,最后存入excel就好了。 查看全部

js 爬虫抓取网页数据(js爬虫抓取网页数据源码分析难度相对高些-苏州安嘉)

js爬虫抓取网页数据,主要分为两部分,一部分是上网页,另一部分是爬数据库。常见的requests库中有selenium模块,但是selenium模块的源码分析难度相对高些,我们用的urllib模块,urllib2就是selenium的selenium模块就是selenium爬虫常用的三种网络请求库:selenium.webdriver.chrome(webdriver类的子类)urllib2.http.forward(url,http头)以下我们只介绍forward请求一般的请求步骤:打开浏览器——获取本地路径(项目文件夹或python文件)——获取页面内容(项目文件夹或python文件)——下载并解压文件——代码存入数据库某个文件中——获取页面内容存入文件xx(项目文件夹或python文件)。

1、打开浏览器获取本地路径(项目文件夹或python文件)在python2下,

2、使用浏览器打开正常模式找到我们需要抓取的页面,

3、获取页面内容(项目文件夹或python文件)importhttplib2fromurllibimportrequestimportxxfromopenerimportbeautifulsoupfromurllib。requestimportrequesturl=''url=''foriinrange(1,1000。

0):urlopen=request.urlopen(url)printurlopen.read()printrequest.urlopen(url)当然不限于这三种方法,以后我们都会介绍到对urllib2的熟悉,它一个库拥有三种方法:urlopen、urlopenxml()、open(),分别用来解析网页内容,调用get函数。我们通过这三种方法抓取网页,最后存入excel就好了。

js 爬虫抓取网页数据(我们自己解析url数据访问你的api好了(组图) )

网站优化 • 优采云 发表了文章 • 0 个评论 • 77 次浏览 • 2022-02-08 09:19

)

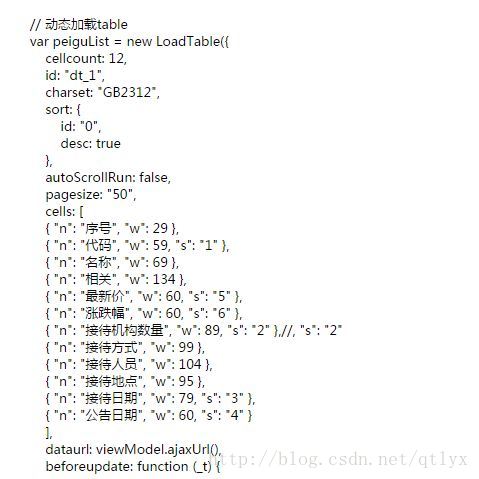

最近会先抓取大量的数据并存储起来,然后再讨论现有的历史数据。其中,东方财富网有很多数据,其中之一就是机构研究的数据。

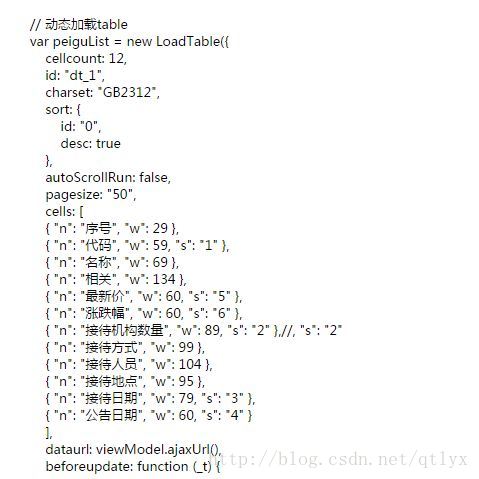

我们要抓取的是js生成的表格。

这种用js爬的网站可没那么简单。它基本上分为几种方法。一种是观察页面,有的有json数据,有的有js代码解析目标url;一是使用渲染工具;另一种是使用工具点击相关按钮抓取url进行进一步分析。

今天我们使用第三个。

我们希望爬取表格中的数据,但是仔细看html代码会发现,这其实是js生成的,下图是源代码截图。

这很尴尬,我该怎么办?让我们自己解析url数据来访问你的api。

我们用浏览器自带的解析功能试试吧。首先,我们打开网络,chrome内核好像是这样叫的。

然后我们点击第二页和第三页,观察js代码访问了哪些后台url。事实是这样

YnQNqDYj¶m=&sortRule=-1&sortType=0&rt=50585869

strLvpoP¶m=&sortRule=-1&sortType=0&rt=50585871

ggPyhcCU¶m=&sortRule=-1&sortType=0&rt=50585871

SjIkKWnA¶m=&sortRule=-1&sortType=0&rt=50585872

我们可以找到模式,本质上是改变paee后面的数字。至于最后一个数字,目前猜测是计数标记,在所有API中设置相同即可。

接下来,我们可以使用urllib来获取api后面的json内容,例如:

查看全部

js 爬虫抓取网页数据(我们自己解析url数据访问你的api好了(组图)

)

最近会先抓取大量的数据并存储起来,然后再讨论现有的历史数据。其中,东方财富网有很多数据,其中之一就是机构研究的数据。

我们要抓取的是js生成的表格。

这种用js爬的网站可没那么简单。它基本上分为几种方法。一种是观察页面,有的有json数据,有的有js代码解析目标url;一是使用渲染工具;另一种是使用工具点击相关按钮抓取url进行进一步分析。

今天我们使用第三个。

我们希望爬取表格中的数据,但是仔细看html代码会发现,这其实是js生成的,下图是源代码截图。

这很尴尬,我该怎么办?让我们自己解析url数据来访问你的api。

我们用浏览器自带的解析功能试试吧。首先,我们打开网络,chrome内核好像是这样叫的。

然后我们点击第二页和第三页,观察js代码访问了哪些后台url。事实是这样

YnQNqDYj¶m=&sortRule=-1&sortType=0&rt=50585869

strLvpoP¶m=&sortRule=-1&sortType=0&rt=50585871

ggPyhcCU¶m=&sortRule=-1&sortType=0&rt=50585871

SjIkKWnA¶m=&sortRule=-1&sortType=0&rt=50585872

我们可以找到模式,本质上是改变paee后面的数字。至于最后一个数字,目前猜测是计数标记,在所有API中设置相同即可。

接下来,我们可以使用urllib来获取api后面的json内容,例如:

js 爬虫抓取网页数据(java程序中获取后台js完后的完整页面是什么?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 56 次浏览 • 2022-02-05 00:10

很多网站使用js或者jquery来生成数据。后台获取数据后,使用document.write()或("#id").html=""写入页面,此时用浏览器查看源码看不到数据。

HttpClient不行,我在网上看了HtmlUnit,说后台js加载后可以得到完整的页面,但是我按照文章说的写了,但是没有不行。一般的代码是这样写的:

String url = "http://xinjinqiao.tprtc.com/ad ... 3B%3B

try {

WebClient webClient = new WebClient(BrowserVersion.FIREFOX_10);

//设置webClient的相关参数

webClient.getOptions().setJavaScriptEnabled(true);

webClient.getOptions().setCssEnabled(false);

webClient.setAjaxController(new NicelyResynchronizingAjaxController());

//webClient.getOptions().setTimeout(50000);

webClient.getOptions().setThrowExceptionOnScriptError(false);

//模拟浏览器打开一个目标网址

HtmlPage rootPage = webClient.getPage(url);

System.out.println("为了获取js执行的数据 线程开始沉睡等待");

Thread.sleep(3000);//主要是这个线程的等待 因为js加载也是需要时间的

System.out.println("线程结束沉睡");

String html = rootPage.asText();

System.out.println(html);

} catch (Exception e) {

}

它根本不起作用。

典型的是链接页面。 java程序中如何获取数据? 查看全部

js 爬虫抓取网页数据(java程序中获取后台js完后的完整页面是什么?)

很多网站使用js或者jquery来生成数据。后台获取数据后,使用document.write()或("#id").html=""写入页面,此时用浏览器查看源码看不到数据。

HttpClient不行,我在网上看了HtmlUnit,说后台js加载后可以得到完整的页面,但是我按照文章说的写了,但是没有不行。一般的代码是这样写的:

String url = "http://xinjinqiao.tprtc.com/ad ... 3B%3B

try {

WebClient webClient = new WebClient(BrowserVersion.FIREFOX_10);

//设置webClient的相关参数

webClient.getOptions().setJavaScriptEnabled(true);

webClient.getOptions().setCssEnabled(false);

webClient.setAjaxController(new NicelyResynchronizingAjaxController());

//webClient.getOptions().setTimeout(50000);

webClient.getOptions().setThrowExceptionOnScriptError(false);

//模拟浏览器打开一个目标网址

HtmlPage rootPage = webClient.getPage(url);

System.out.println("为了获取js执行的数据 线程开始沉睡等待");

Thread.sleep(3000);//主要是这个线程的等待 因为js加载也是需要时间的

System.out.println("线程结束沉睡");

String html = rootPage.asText();

System.out.println(html);

} catch (Exception e) {

}

它根本不起作用。

典型的是链接页面。 java程序中如何获取数据?

js 爬虫抓取网页数据(cheerio模块、request模块的基本流程推荐次数推荐(一))

网站优化 • 优采云 发表了文章 • 0 个评论 • 64 次浏览 • 2022-02-04 21:07

在node.js中,配合cheerio模块和request模块,可以非常方便的抓取特定URL页面的数据。

一个简单的如下

var request = require('request');

varcheerio = 需要('cheerio');

请求(url,函数(err,res){

if(err) return console.log(err);

var $ =cheerio.load(res.body.toString());

//解析页面内容

});

有了基本流程,现在试着找一个网址(url)。以博客园的搜索页面为例。

通过搜索 关键词node.js

获取以下网址:

点击第二页,网址如下:

分析 URL 并发现 w=?是 关键词 p=?是要搜索的页码。

使用请求模块请求一个 URL

var request = require('request');

varcheerio = 需要('cheerio');

var key = 'node.js', page = 1;

var url = '#39;+ key +'&p='+ page;

请求(url,函数(错误,res){

if (err) return console.log(err);

var $ =cheerio.load(res.body.toString());

var arr = [];

//内容解析

});

既然URL已经可用,接下来分析该URL对应的页面内容。

页面还是很规整的。

标题 摘要 作者 发帖时间 推荐 评论 浏览量 文章链接

使用浏览器开发工具

发现

...

对应每个文章

点击每一项,有以下内容

class="searchItemTitle" 收录 文章title 和 文章URL 地址

class="searchItemInfo-userName" 收录作者

class="searchItemInfo-publishDate" 收录发布时间

class="searchItemInfo-views" 收录视图

借助cheerio模块解析文章,抓取具体内容

var request = require('request');

varcheerio = 需要('cheerio');

var key = 'node.js', page = 1;

var url = '#39;+ key +'&p='+ page;

请求(url,函数(错误,res){

if (err) return console.log(err);

var $ =cheerio.load(res.body.toString());

var arr = [];

//内容解析

$('.searchItem').each(function() {

var title = $(this).find('.searchItemTitle');

var author = $(this).find('.searchItemInfo-userName a');

var time = $(this).find('.searchItemInfo-publishDate');

var view = $(this).find('.searchItemInfo-views');

变量信息 = {

标题:$(title).find('a').text(),

href: $(title).find('a').attr('href'),

作者:$(author).text(),

时间:$(time).text(),

视图:$(view).text().replace(/[^0-9]/ig, '')

};

arr.push(信息);

//打印

console.log('===============================输出开始========== = =================');

console.log(info);

console.log('=============================== 输出结束========= == =================');

});

});

查看代码

你可以运行它看看数据是否被正常抓取。

现在可以将数据数据保存到数据库中。这里以mysql为例,使用mongodb更方便。

借助mysql模块保存数据(假设数据库名为test,表为blog)。

var request = require('request');

varcheerio = 需要('cheerio');

var mysql = require('mysql');

var db = mysql.createConnection({

主机:'127.0.0.1',

用户:'root',

密码:'123456',

数据库:“测试”

});

db.connect();

var key = 'node.js', page = 1;

var url = '#39;+ key +'&p='+ page;

请求(url,函数(错误,res){

if (err) return console.log(err);

var $ =cheerio.load(res.body.toString());

var arr = [];

//内容解析

$('.searchItem').each(function() {

var title = $(this).find('.searchItemTitle');

var author = $(this).find('.searchItemInfo-userName a');

var time = $(this).find('.searchItemInfo-publishDate');

var view = $(this).find('.searchItemInfo-views');

变量信息 = {

标题:$(title).find('a').text(),

href: $(title).find('a').attr('href'),

作者:$(author).text(),

时间:$(time).text(),

视图:$(view).text().replace(/[^0-9]/ig, '')

};

arr.push(信息);

//打印

console.log('===============================输出开始========== = =================');

console.log(info);

console.log('=============================== 输出结束========= == =================');

//保存数据

db.query('插入博客集?', info, function(err,result){

如果(错误)抛出错误;

如果(!!结果){

console.log('插入成功');

console.log(result.insertId);

} 否则 {

console.log('插入失败');

}

});

});

});

查看代码

运行并查看数据是否保存到数据库中。

现在可以进行基本的抓取和保存。但是只爬取了一次,只有关键词为node.js页码的URL页面为1。

把关键词改成javascript,页码为1,清空blog表,然后再次运行,看看能不能把javascript相关的数据保存到表中。

现在去博客园搜索javascript,看看搜索结果是否与表格中的内容对应。呵呵,不看,肯定会对应~~

只能爬取一页的内容,这肯定是不够的。自动爬取其他页面的内容会更好。 查看全部

js 爬虫抓取网页数据(cheerio模块、request模块的基本流程推荐次数推荐(一))

在node.js中,配合cheerio模块和request模块,可以非常方便的抓取特定URL页面的数据。

一个简单的如下

var request = require('request');

varcheerio = 需要('cheerio');

请求(url,函数(err,res){

if(err) return console.log(err);

var $ =cheerio.load(res.body.toString());

//解析页面内容

});

有了基本流程,现在试着找一个网址(url)。以博客园的搜索页面为例。

通过搜索 关键词node.js

获取以下网址:

点击第二页,网址如下:

分析 URL 并发现 w=?是 关键词 p=?是要搜索的页码。

使用请求模块请求一个 URL

var request = require('request');

varcheerio = 需要('cheerio');

var key = 'node.js', page = 1;

var url = '#39;+ key +'&p='+ page;

请求(url,函数(错误,res){

if (err) return console.log(err);

var $ =cheerio.load(res.body.toString());

var arr = [];

//内容解析

});

既然URL已经可用,接下来分析该URL对应的页面内容。

页面还是很规整的。

标题 摘要 作者 发帖时间 推荐 评论 浏览量 文章链接

使用浏览器开发工具

发现

...

对应每个文章

点击每一项,有以下内容

class="searchItemTitle" 收录 文章title 和 文章URL 地址

class="searchItemInfo-userName" 收录作者

class="searchItemInfo-publishDate" 收录发布时间

class="searchItemInfo-views" 收录视图

借助cheerio模块解析文章,抓取具体内容

var request = require('request');

varcheerio = 需要('cheerio');

var key = 'node.js', page = 1;

var url = '#39;+ key +'&p='+ page;

请求(url,函数(错误,res){

if (err) return console.log(err);

var $ =cheerio.load(res.body.toString());

var arr = [];

//内容解析

$('.searchItem').each(function() {

var title = $(this).find('.searchItemTitle');

var author = $(this).find('.searchItemInfo-userName a');

var time = $(this).find('.searchItemInfo-publishDate');

var view = $(this).find('.searchItemInfo-views');

变量信息 = {

标题:$(title).find('a').text(),

href: $(title).find('a').attr('href'),

作者:$(author).text(),

时间:$(time).text(),

视图:$(view).text().replace(/[^0-9]/ig, '')

};

arr.push(信息);

//打印

console.log('===============================输出开始========== = =================');

console.log(info);

console.log('=============================== 输出结束========= == =================');

});

});

查看代码

你可以运行它看看数据是否被正常抓取。

现在可以将数据数据保存到数据库中。这里以mysql为例,使用mongodb更方便。

借助mysql模块保存数据(假设数据库名为test,表为blog)。

var request = require('request');

varcheerio = 需要('cheerio');

var mysql = require('mysql');

var db = mysql.createConnection({

主机:'127.0.0.1',

用户:'root',

密码:'123456',

数据库:“测试”

});

db.connect();

var key = 'node.js', page = 1;

var url = '#39;+ key +'&p='+ page;

请求(url,函数(错误,res){

if (err) return console.log(err);

var $ =cheerio.load(res.body.toString());

var arr = [];

//内容解析

$('.searchItem').each(function() {

var title = $(this).find('.searchItemTitle');

var author = $(this).find('.searchItemInfo-userName a');

var time = $(this).find('.searchItemInfo-publishDate');

var view = $(this).find('.searchItemInfo-views');

变量信息 = {

标题:$(title).find('a').text(),

href: $(title).find('a').attr('href'),

作者:$(author).text(),

时间:$(time).text(),

视图:$(view).text().replace(/[^0-9]/ig, '')

};

arr.push(信息);

//打印

console.log('===============================输出开始========== = =================');

console.log(info);

console.log('=============================== 输出结束========= == =================');

//保存数据

db.query('插入博客集?', info, function(err,result){

如果(错误)抛出错误;

如果(!!结果){

console.log('插入成功');

console.log(result.insertId);

} 否则 {

console.log('插入失败');

}

});

});

});

查看代码

运行并查看数据是否保存到数据库中。

现在可以进行基本的抓取和保存。但是只爬取了一次,只有关键词为node.js页码的URL页面为1。

把关键词改成javascript,页码为1,清空blog表,然后再次运行,看看能不能把javascript相关的数据保存到表中。

现在去博客园搜索javascript,看看搜索结果是否与表格中的内容对应。呵呵,不看,肯定会对应~~

只能爬取一页的内容,这肯定是不够的。自动爬取其他页面的内容会更好。

js 爬虫抓取网页数据(JS搭建后台环境始终略为麻烦,可不可以直接在浏览器客户端直接实现)

网站优化 • 优采云 发表了文章 • 0 个评论 • 52 次浏览 • 2022-02-04 20:20

JS 是一种神奇的语言。有了Node.js的后端环境,我们就可以开发相应的爬虫了。不过搭建后台环境总是有点麻烦。当你拿到一台新电脑时,你不需要配置环境。可以直接在浏览器客户端实现吗?

答案肯定是肯定的。这里简单介绍一下在浏览器客户端实现爬取页面数据的爬虫。

爬虫,简单来说就是发送一个请求,然后按照一定的逻辑解析得到的数据。在 Node 环境下,可以使用 Request 模块请求地址,获取返回信息,然后使用正则匹配数据,或者使用 Cheerio 模块进行包装,方便定位相关标签。

在浏览器环境下也是类似的,可以使用标签的src属性或者ajax请求地址,获取返回信息,然后使用正则匹配的数据,或者使用jQuery模块进行包装——很方便定位相关标签项

实现的本质是打开浏览器的开发者工具,写一段JS代码注入到页面中,然后让相关代码自行执行地址请求,再通过代码处理返回的数据,打开Chrome浏览器的开发者工具,选择面板。在sources部分,选择二级菜单的script snippets部分,然后右键新建脚本,在右侧输入你要注入的代码,然后右键scriptsnippets脚本运行(或者使用快捷键 Ctrl + Enter 运行)开始注入,你可以在下面的控制台部分看到相应的结果。注入JS代码的方式是使用一个script标签来定义src指向的脚本地址, 查看全部

js 爬虫抓取网页数据(JS搭建后台环境始终略为麻烦,可不可以直接在浏览器客户端直接实现)

JS 是一种神奇的语言。有了Node.js的后端环境,我们就可以开发相应的爬虫了。不过搭建后台环境总是有点麻烦。当你拿到一台新电脑时,你不需要配置环境。可以直接在浏览器客户端实现吗?

答案肯定是肯定的。这里简单介绍一下在浏览器客户端实现爬取页面数据的爬虫。

爬虫,简单来说就是发送一个请求,然后按照一定的逻辑解析得到的数据。在 Node 环境下,可以使用 Request 模块请求地址,获取返回信息,然后使用正则匹配数据,或者使用 Cheerio 模块进行包装,方便定位相关标签。

在浏览器环境下也是类似的,可以使用标签的src属性或者ajax请求地址,获取返回信息,然后使用正则匹配的数据,或者使用jQuery模块进行包装——很方便定位相关标签项

实现的本质是打开浏览器的开发者工具,写一段JS代码注入到页面中,然后让相关代码自行执行地址请求,再通过代码处理返回的数据,打开Chrome浏览器的开发者工具,选择面板。在sources部分,选择二级菜单的script snippets部分,然后右键新建脚本,在右侧输入你要注入的代码,然后右键scriptsnippets脚本运行(或者使用快捷键 Ctrl + Enter 运行)开始注入,你可以在下面的控制台部分看到相应的结果。注入JS代码的方式是使用一个script标签来定义src指向的脚本地址,

js 爬虫抓取网页数据(编程的“回调地狱”和下方的新闻数据(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 61 次浏览 • 2022-02-04 20:13

1、首先我们来分析一下百度新闻首页的页面信息。

百度新闻首页大致分为“热点新闻”、“本地新闻”、“国内新闻”、“国际新闻”……等。这次,我们尝试从左侧的“热点新闻”和下方的“本地新闻”中抓取新闻数据。

F12 打开Chrome控制台,查看页面元素,查看左侧“热点新闻”信息所在的DOM结构后,发现所有“热点新闻”信息(包括新闻头条和新闻页面链接)在#pane-news 的 id 中

> 在下面的选项卡中。在 jQuery 选择器中:#pane-news ul li a.

2、为了爬取新闻数据,首先我们使用superagent请求目标页面,获取整个新闻首页信息

// 引入所需要的第三方包

const superagent= require('superagent');

let hotNews = []; // 热点新闻

let localNews = []; // 本地新闻

/**

* index.js

* [description] - 使用superagent.get()方法来访问百度新闻首页

*/

superagent.get('http://news.baidu.com/').end((err, res) => {

if (err) {

// 如果访问失败或者出错,会这行这里

console.log(`热点新闻抓取失败 - ${err}`)

} else {

// 访问成功,请求http://news.baidu.com/页面所返回的数据会包含在res

// 抓取热点新闻数据

hotNews = getHotNews(res)

}

});

3、获取到页面信息后,我们定义一个函数getHotNews()来抓取页面中的“热点新闻”数据。

/**

* index.js

* [description] - 抓取热点新闻页面

*/

// 引入所需要的第三方包

const cheerio = require('cheerio');

let getHotNews = (res) => {

let hotNews = [];

// 访问成功,请求http://news.baidu.com/页面所返回的数据会包含在res.text中。

/* 使用cheerio模块的cherrio.load()方法,将HTMLdocument作为参数传入函数

以后就可以使用类似jQuery的$(selectior)的方式来获取页面元素

*/

let $ = cheerio.load(res.text);

// 找到目标数据所在的页面元素,获取数据

$('div#pane-news ul li a').each((idx, ele) => {

// cherrio中$('selector').each()用来遍历所有匹配到的DOM元素

// 参数idx是当前遍历的元素的索引,ele就是当前便利的DOM元素

let news = {

title: $(ele).text(), // 获取新闻标题

href: $(ele).attr('href') // 获取新闻网页链接

};

hotNews.push(news) // 存入最终结果数组

});

return hotNews

};

这里多说几句:

async/await 据说是异步编程的终极解决方案,它让我们能够以同步的思维方式进行异步编程。Promise 解决了异步编程的“回调地狱”。Async/await 还使异步过程控制变得友好和清晰。有兴趣的同学可以了解一下。它真的很有用。superagent模块提供了get、post、delte等多种方法,可以方便的进行ajax请求操作。请求结束后执行 .end() 回调函数。.end() 接受一个函数作为参数,该函数又具有两个参数 error 和 res。当请求失败时,error 将收录返回的错误信息。如果请求成功,则错误值为null,返回的数据会收录在res参数中。这 。Cheerio 模块的 load() 方法将 HTML 文档作为参数传入函数中,然后可以使用类似于 jQuery 的 $(selectior) 的方法来获取页面元素。您还可以使用类似于 jQuery 的 .each() 来迭代元素。另外,还有很多方法,你可以自己google/baidu。

4、将抓取的数据返回给前端浏览器

之前, const app = express(); 实例化一个 express 对象应用程序。

app.get('', async() => {}) 接受两个参数,第一个参数接受一个String类型的路由路径,代表Ajax的请求路径。第二个参数接受一个函数Function,该函数中的代码在请求路径时执行。

/**

* [description] - 跟路由

*/

// 当一个get请求 http://localhost:3000时,就会后面的async函数

app.get('/', async (req, res, next) => {

res.send(hotNews);

});

在DOS下执行项目根目录baiduNews下的node index.js,使项目运行起来。之后打开浏览器,访问:3000,你会发现抓取到的数据返回到前端页面。我运行代码后浏览器显示的返回信息如下:

注意:因为我的 Chrome 上安装了 JSONView 扩展,所以在显示页面时,返回的数据会自动格式化成结构化的 JSON 格式,方便查看。

行!!这样,一个简单的百度“热点新闻”爬虫就完成了!!

总结一下,步骤其实很简单:

Express启动一个简单的Http服务,分析目标页面的DOM结构,找到要抓取信息的相关DOM元素,使用superagent请求目标页面,使用cheerio获取页面元素,获取目标数据并返回数据到前端浏览器

现在,继续我们抓取“本地新闻”数据的目标(在编码时,我们会遇到一些有趣的问题)

有了之前的基础,我们自然会想到对“地方新闻”数据采用和上面一样的方法。

1、 分析页面“本地新闻”板块的DOM结构,如下图:

F12打开控制台查看“本地新闻”DOM元素,我们发现“本地新闻”主要分为“左侧新闻”和右侧“新闻”两部分。所有这些目标数据都在一个 ID 为 #local_news 的 div 中。“左新闻”数据在 ul 标签下的 li 标签下的 a 标签中,id 为#localnews-focus,包括新闻标题和页面链接。“本地新闻”数据在id为#localnews-zixun的div下的ul标签下的li标签下的a标签中,包括新闻头条和页面链接。

2、好的!分析DOM结构并确定数据的位置。接下来就像爬取“热点新闻”一样,一步一步定义一个getLocalNews()函数来爬取数据。

/**

* [description] - 抓取本地新闻页面

*/

let getLocalNews = (res) => {

let localNews = [];

let $ = cheerio.load(res);

// 本地新闻

$('ul#localnews-focus li a').each((idx, ele) => {

let news = {

title: $(ele).text(),

href: $(ele).attr('href'),

};

localNews.push(news)

});

// 本地资讯

$('div#localnews-zixun ul li a').each((index, item) => {

let news = {

title: $(item).text(),

href: $(item).attr('href')

};

localNews.push(news);

});

return localNews

};

相应的,在superagent.get()中请求页面后,我们需要调用getLocalNews()函数来抓取本地新闻数据。

superagent.get() 函数修改为:

superagent.get('http://news.baidu.com/').end((err, res) => {

if (err) {

// 如果访问失败或者出错,会这行这里

console.log(`热点新闻抓取失败 - ${err}`)

} else {

// 访问成功,请求http://news.baidu.com/页面所返回的数据会包含在res

// 抓取热点新闻数据

hotNews = getHotNews(res)

localNews = getLocalNews(res)

}

});

同时,我们需要在 app.get() 路由中将数据返回给前端浏览器。app.get() 路由代码修改为:

/**

* [description] - 跟路由

*/

// 当一个get请求 http://localhost:3000时,就会后面的async函数

app.get('/', async (req, res, next) => {

res.send({

hotNews: hotNews,

localNews: localNews

});

});

代码完成了,好激动!!让项目在DOS下运行,使用浏览器访问:3000

尴尬的事情发生了!!返回的数据只是热点新闻,本地新闻返回一个空数组[ ]。检查代码,发现没有问题,但是为什么一直返回一个空数组呢?

经过一番搜索,我发现问题出在哪里!!

一个有趣的问题 为了找到原因,首先我们看一下使用 superagent.get('').end((err, res) => {}) 在回调函数 .end() 中请求第二个百度新闻首页 参数 res 究竟得到了什么?

// 新定义一个全局变量 pageRes

let pageRes = {}; // supergaent页面返回值

// superagent.get()中将res存入pageRes

superagent.get('http://news.baidu.com/').end((err, res) => {

if (err) {

// 如果访问失败或者出错,会这行这里

console.log(`热点新闻抓取失败 - ${err}`)

} else {

// 访问成功,请求http://news.baidu.com/页面所返回的数据会包含在res

// 抓取热点新闻数据

// hotNews = getHotNews(res)

// localNews = getLocalNews(res)

pageRes = res

}

});

// 将pageRes返回给前端浏览器,便于查看

app.get('/', async (req, res, next) => {

res.send({

// {}hotNews: hotNews,

// localNews: localNews,

pageRes: pageRes

});

});

访问浏览器:3000,页面显示如下内容:

可以看到,返回值中的文本字段应该是整个页面的HTML代码的字符串格式。为了方便我们观察,我们可以直接将文本字段值返回给前端浏览器,这样就可以清楚的看到浏览器渲染的页面。

修改返回值到前端浏览器

app.get('/', async (req, res, next) => {

res.send(pageRes.text)

}

访问浏览器:3000,页面显示如下内容:

回顾元素后发现我们抓取的目标数据所在的DOM元素是空的,里面也没有数据!

在这里,一切都归结为它!当我们使用superagent.get()访问百度新闻首页时,在获取到的res收录的页面内容中,还没有生成我们想要的“本地新闻”数据,并且DOM节点元素为空,所以出现了前面的情况!抓取后返回的数据始终为空数组[ ]。

在控制台的Network中,我们发现页面曾经请求过这样一个接口:

:3000/widget?id=LocalNews&ajax=json&t=17,接口状态404。

这应该是百度新闻获取“本地新闻”的接口。一切都在这里了!“本地新闻”是在页面加载完成后动态请求上述接口获取的,所以当我们使用superagent.get()请求的页面请求这个接口时,接口URL的hostname部分就变成了本地IP地址,而本机没有这个接口,所以404,没有请求数据。

找到原因,让我们想办法解决这个问题!!

直接使用superagent访问正确合法的百度“本地新闻”界面,获取数据返回给前端浏览器。使用第三方npm包模拟浏览器访问百度新闻首页。在这个模拟浏览器中,当“本地新闻”加载成功后,数据被抓取并返回给前端浏览器。

上面的方法都可以用,我们试试第二种更有趣的方法

使用 Nightmare 自动化测试工具 Electron,您可以使用纯 JavaScript 调用 Chrome 丰富的原生接口来创建桌面应用程序。您可以将其视为 Node.js 的变体,专注于桌面应用程序而不是 Web 服务器。其基于浏览器的应用方式可以很方便的进行各种响应式交互

Nightmare 是一个基于 Electron 的 Web 自动化测试和爬虫框架,因为它具有和 PlantomJS 一样的自动化测试功能,可以模拟用户在页面上的行为来触发一些异步数据加载,也可以像 Request 一样直接访问 URL图书馆。抓取数据,您可以设置页面的延迟时间,因此手动或行为触发脚本变得轻而易举。

安装依赖项

// 安装nightmare

yarn add nightmare

要获取“本地新闻”,请继续编码...

将以下代码添加到 index.js:

const Nightmare = require('nightmare'); // 自动化测试包,处理动态页面

const nightmare = Nightmare({ show: true }); // show:true 显示内置模拟浏览器

/**

* [description] - 抓取本地新闻页面

* [nremark] - 百度本地新闻在访问页面后加载js定位IP位置后获取对应新闻,

* 所以抓取本地新闻需要使用 nightmare 一类的自动化测试工具,

* 模拟浏览器环境访问页面,使js运行,生成动态页面再抓取

*/

// 抓取本地新闻页面

nightmare

.goto('http://news.baidu.com/')

.wait("div#local_news")

.evaluate(() => document.querySelector("div#local_news").innerHTML)

.then(htmlStr => {

// 获取本地新闻数据

localNews = getLocalNews(htmlStr)

})

.catch(error => {

console.log(`本地新闻抓取失败 - ${error}`);

})

将 getLocalNews() 函数修改为:

/**

* [description]- 获取本地新闻数据

*/

let getLocalNews = (htmlStr) => {

let localNews = [];

let $ = cheerio.load(htmlStr);

// 本地新闻

$('ul#localnews-focus li a').each((idx, ele) => {

let news = {

title: $(ele).text(),

href: $(ele).attr('href'),

};

localNews.push(news)

});

// 本地资讯

$('div#localnews-zixun ul li a').each((index, item) => {

let news = {

title: $(item).text(),

href: $(item).attr('href')

};

localNews.push(news);

});

return localNews

}

修改 app.get('/') 路由为:

/**

* [description] - 跟路由

*/

// 当一个get请求 http://localhost:3000时,就会后面的async函数

app.get('/', async (req, res, next) => {

res.send({

hotNews: hotNews,

localNews: localNews

})

});

此时,让项目再次在DOS命令行下运行,浏览器访问:3000查看页面显示的信息,看看“本地新闻”数据是否被抓取!

至此,一个简单完整的爬取百度新闻页面“热点新闻”和“本地新闻”的爬虫就完成了!!

最后,总结一下,整体思路如下:

Express 启动一个简单的 Http 服务来分析目标页面的 DOM 结构,并找到要捕获的信息的相关 DOM 元素。使用superagent请求目标页面的动态页面(需要运行JS的页面或者加载页面后请求界面)可以使用Nightmare模拟浏览器访问使用cheerio获取页面元素并获取目标数据完整代码爬虫完成代码GitHub地址:完整代码

后面应该有一些进阶的步骤来爬取网站上的一些好看的图片(手动搞笑),这里面会涉及到一些并发控制和反反爬虫的策略。然后使用爬虫抓取一些需要登录并输入验证码的网站。欢迎大家关注和正确沟通。

再次感谢大家的点赞、关注和评论,感谢大家的支持,谢谢!我自己认为我是一个热爱文字、音乐和编码的半文学程序员。我一直在考虑写关于技术和其他文学的文章。虽然我的基础不是那么好,但我总觉得在写文章的过程中,无论是技术还是文学,都能督促自己去思考,督促自己去学习和交流。毕竟,除了每天忙碌之外,我还要过自己不一样的生活。所以,如果以后有什么好的文章,我会积极的分享给大家!再次感谢大家的支持!

节点.js

阅读34.8k更新于2020-01-09 查看全部

js 爬虫抓取网页数据(编程的“回调地狱”和下方的新闻数据(组图))

1、首先我们来分析一下百度新闻首页的页面信息。

百度新闻首页大致分为“热点新闻”、“本地新闻”、“国内新闻”、“国际新闻”……等。这次,我们尝试从左侧的“热点新闻”和下方的“本地新闻”中抓取新闻数据。

F12 打开Chrome控制台,查看页面元素,查看左侧“热点新闻”信息所在的DOM结构后,发现所有“热点新闻”信息(包括新闻头条和新闻页面链接)在#pane-news 的 id 中

> 在下面的选项卡中。在 jQuery 选择器中:#pane-news ul li a.

2、为了爬取新闻数据,首先我们使用superagent请求目标页面,获取整个新闻首页信息

// 引入所需要的第三方包

const superagent= require('superagent');

let hotNews = []; // 热点新闻

let localNews = []; // 本地新闻

/**

* index.js

* [description] - 使用superagent.get()方法来访问百度新闻首页

*/

superagent.get('http://news.baidu.com/').end((err, res) => {

if (err) {

// 如果访问失败或者出错,会这行这里

console.log(`热点新闻抓取失败 - ${err}`)

} else {

// 访问成功,请求http://news.baidu.com/页面所返回的数据会包含在res

// 抓取热点新闻数据

hotNews = getHotNews(res)

}

});

3、获取到页面信息后,我们定义一个函数getHotNews()来抓取页面中的“热点新闻”数据。

/**

* index.js

* [description] - 抓取热点新闻页面

*/

// 引入所需要的第三方包

const cheerio = require('cheerio');

let getHotNews = (res) => {

let hotNews = [];

// 访问成功,请求http://news.baidu.com/页面所返回的数据会包含在res.text中。

/* 使用cheerio模块的cherrio.load()方法,将HTMLdocument作为参数传入函数

以后就可以使用类似jQuery的$(selectior)的方式来获取页面元素

*/

let $ = cheerio.load(res.text);

// 找到目标数据所在的页面元素,获取数据

$('div#pane-news ul li a').each((idx, ele) => {

// cherrio中$('selector').each()用来遍历所有匹配到的DOM元素

// 参数idx是当前遍历的元素的索引,ele就是当前便利的DOM元素

let news = {

title: $(ele).text(), // 获取新闻标题

href: $(ele).attr('href') // 获取新闻网页链接

};

hotNews.push(news) // 存入最终结果数组

});

return hotNews

};

这里多说几句:

async/await 据说是异步编程的终极解决方案,它让我们能够以同步的思维方式进行异步编程。Promise 解决了异步编程的“回调地狱”。Async/await 还使异步过程控制变得友好和清晰。有兴趣的同学可以了解一下。它真的很有用。superagent模块提供了get、post、delte等多种方法,可以方便的进行ajax请求操作。请求结束后执行 .end() 回调函数。.end() 接受一个函数作为参数,该函数又具有两个参数 error 和 res。当请求失败时,error 将收录返回的错误信息。如果请求成功,则错误值为null,返回的数据会收录在res参数中。这 。Cheerio 模块的 load() 方法将 HTML 文档作为参数传入函数中,然后可以使用类似于 jQuery 的 $(selectior) 的方法来获取页面元素。您还可以使用类似于 jQuery 的 .each() 来迭代元素。另外,还有很多方法,你可以自己google/baidu。

4、将抓取的数据返回给前端浏览器

之前, const app = express(); 实例化一个 express 对象应用程序。

app.get('', async() => {}) 接受两个参数,第一个参数接受一个String类型的路由路径,代表Ajax的请求路径。第二个参数接受一个函数Function,该函数中的代码在请求路径时执行。

/**

* [description] - 跟路由

*/

// 当一个get请求 http://localhost:3000时,就会后面的async函数

app.get('/', async (req, res, next) => {

res.send(hotNews);

});

在DOS下执行项目根目录baiduNews下的node index.js,使项目运行起来。之后打开浏览器,访问:3000,你会发现抓取到的数据返回到前端页面。我运行代码后浏览器显示的返回信息如下:

注意:因为我的 Chrome 上安装了 JSONView 扩展,所以在显示页面时,返回的数据会自动格式化成结构化的 JSON 格式,方便查看。

行!!这样,一个简单的百度“热点新闻”爬虫就完成了!!

总结一下,步骤其实很简单:

Express启动一个简单的Http服务,分析目标页面的DOM结构,找到要抓取信息的相关DOM元素,使用superagent请求目标页面,使用cheerio获取页面元素,获取目标数据并返回数据到前端浏览器

现在,继续我们抓取“本地新闻”数据的目标(在编码时,我们会遇到一些有趣的问题)

有了之前的基础,我们自然会想到对“地方新闻”数据采用和上面一样的方法。

1、 分析页面“本地新闻”板块的DOM结构,如下图:

F12打开控制台查看“本地新闻”DOM元素,我们发现“本地新闻”主要分为“左侧新闻”和右侧“新闻”两部分。所有这些目标数据都在一个 ID 为 #local_news 的 div 中。“左新闻”数据在 ul 标签下的 li 标签下的 a 标签中,id 为#localnews-focus,包括新闻标题和页面链接。“本地新闻”数据在id为#localnews-zixun的div下的ul标签下的li标签下的a标签中,包括新闻头条和页面链接。

2、好的!分析DOM结构并确定数据的位置。接下来就像爬取“热点新闻”一样,一步一步定义一个getLocalNews()函数来爬取数据。

/**

* [description] - 抓取本地新闻页面

*/

let getLocalNews = (res) => {

let localNews = [];

let $ = cheerio.load(res);

// 本地新闻

$('ul#localnews-focus li a').each((idx, ele) => {

let news = {

title: $(ele).text(),

href: $(ele).attr('href'),

};

localNews.push(news)

});

// 本地资讯

$('div#localnews-zixun ul li a').each((index, item) => {

let news = {

title: $(item).text(),

href: $(item).attr('href')

};

localNews.push(news);

});

return localNews

};

相应的,在superagent.get()中请求页面后,我们需要调用getLocalNews()函数来抓取本地新闻数据。

superagent.get() 函数修改为:

superagent.get('http://news.baidu.com/').end((err, res) => {

if (err) {

// 如果访问失败或者出错,会这行这里

console.log(`热点新闻抓取失败 - ${err}`)

} else {

// 访问成功,请求http://news.baidu.com/页面所返回的数据会包含在res

// 抓取热点新闻数据

hotNews = getHotNews(res)

localNews = getLocalNews(res)

}

});

同时,我们需要在 app.get() 路由中将数据返回给前端浏览器。app.get() 路由代码修改为:

/**

* [description] - 跟路由

*/

// 当一个get请求 http://localhost:3000时,就会后面的async函数

app.get('/', async (req, res, next) => {

res.send({

hotNews: hotNews,

localNews: localNews

});

});

代码完成了,好激动!!让项目在DOS下运行,使用浏览器访问:3000

尴尬的事情发生了!!返回的数据只是热点新闻,本地新闻返回一个空数组[ ]。检查代码,发现没有问题,但是为什么一直返回一个空数组呢?

经过一番搜索,我发现问题出在哪里!!

一个有趣的问题 为了找到原因,首先我们看一下使用 superagent.get('').end((err, res) => {}) 在回调函数 .end() 中请求第二个百度新闻首页 参数 res 究竟得到了什么?

// 新定义一个全局变量 pageRes

let pageRes = {}; // supergaent页面返回值

// superagent.get()中将res存入pageRes

superagent.get('http://news.baidu.com/').end((err, res) => {

if (err) {

// 如果访问失败或者出错,会这行这里

console.log(`热点新闻抓取失败 - ${err}`)

} else {

// 访问成功,请求http://news.baidu.com/页面所返回的数据会包含在res

// 抓取热点新闻数据

// hotNews = getHotNews(res)

// localNews = getLocalNews(res)

pageRes = res

}

});

// 将pageRes返回给前端浏览器,便于查看

app.get('/', async (req, res, next) => {

res.send({

// {}hotNews: hotNews,

// localNews: localNews,

pageRes: pageRes

});

});

访问浏览器:3000,页面显示如下内容:

可以看到,返回值中的文本字段应该是整个页面的HTML代码的字符串格式。为了方便我们观察,我们可以直接将文本字段值返回给前端浏览器,这样就可以清楚的看到浏览器渲染的页面。

修改返回值到前端浏览器

app.get('/', async (req, res, next) => {

res.send(pageRes.text)

}

访问浏览器:3000,页面显示如下内容:

回顾元素后发现我们抓取的目标数据所在的DOM元素是空的,里面也没有数据!

在这里,一切都归结为它!当我们使用superagent.get()访问百度新闻首页时,在获取到的res收录的页面内容中,还没有生成我们想要的“本地新闻”数据,并且DOM节点元素为空,所以出现了前面的情况!抓取后返回的数据始终为空数组[ ]。

在控制台的Network中,我们发现页面曾经请求过这样一个接口:

:3000/widget?id=LocalNews&ajax=json&t=17,接口状态404。

这应该是百度新闻获取“本地新闻”的接口。一切都在这里了!“本地新闻”是在页面加载完成后动态请求上述接口获取的,所以当我们使用superagent.get()请求的页面请求这个接口时,接口URL的hostname部分就变成了本地IP地址,而本机没有这个接口,所以404,没有请求数据。

找到原因,让我们想办法解决这个问题!!

直接使用superagent访问正确合法的百度“本地新闻”界面,获取数据返回给前端浏览器。使用第三方npm包模拟浏览器访问百度新闻首页。在这个模拟浏览器中,当“本地新闻”加载成功后,数据被抓取并返回给前端浏览器。

上面的方法都可以用,我们试试第二种更有趣的方法

使用 Nightmare 自动化测试工具 Electron,您可以使用纯 JavaScript 调用 Chrome 丰富的原生接口来创建桌面应用程序。您可以将其视为 Node.js 的变体,专注于桌面应用程序而不是 Web 服务器。其基于浏览器的应用方式可以很方便的进行各种响应式交互

Nightmare 是一个基于 Electron 的 Web 自动化测试和爬虫框架,因为它具有和 PlantomJS 一样的自动化测试功能,可以模拟用户在页面上的行为来触发一些异步数据加载,也可以像 Request 一样直接访问 URL图书馆。抓取数据,您可以设置页面的延迟时间,因此手动或行为触发脚本变得轻而易举。

安装依赖项

// 安装nightmare

yarn add nightmare

要获取“本地新闻”,请继续编码...

将以下代码添加到 index.js:

const Nightmare = require('nightmare'); // 自动化测试包,处理动态页面

const nightmare = Nightmare({ show: true }); // show:true 显示内置模拟浏览器

/**

* [description] - 抓取本地新闻页面

* [nremark] - 百度本地新闻在访问页面后加载js定位IP位置后获取对应新闻,

* 所以抓取本地新闻需要使用 nightmare 一类的自动化测试工具,

* 模拟浏览器环境访问页面,使js运行,生成动态页面再抓取

*/

// 抓取本地新闻页面

nightmare

.goto('http://news.baidu.com/')

.wait("div#local_news")

.evaluate(() => document.querySelector("div#local_news").innerHTML)

.then(htmlStr => {

// 获取本地新闻数据

localNews = getLocalNews(htmlStr)

})

.catch(error => {

console.log(`本地新闻抓取失败 - ${error}`);

})

将 getLocalNews() 函数修改为:

/**

* [description]- 获取本地新闻数据

*/

let getLocalNews = (htmlStr) => {

let localNews = [];

let $ = cheerio.load(htmlStr);

// 本地新闻

$('ul#localnews-focus li a').each((idx, ele) => {

let news = {

title: $(ele).text(),

href: $(ele).attr('href'),

};

localNews.push(news)

});

// 本地资讯

$('div#localnews-zixun ul li a').each((index, item) => {

let news = {

title: $(item).text(),

href: $(item).attr('href')

};

localNews.push(news);

});

return localNews

}

修改 app.get('/') 路由为:

/**

* [description] - 跟路由

*/

// 当一个get请求 http://localhost:3000时,就会后面的async函数

app.get('/', async (req, res, next) => {

res.send({

hotNews: hotNews,

localNews: localNews

})

});

此时,让项目再次在DOS命令行下运行,浏览器访问:3000查看页面显示的信息,看看“本地新闻”数据是否被抓取!

至此,一个简单完整的爬取百度新闻页面“热点新闻”和“本地新闻”的爬虫就完成了!!

最后,总结一下,整体思路如下:

Express 启动一个简单的 Http 服务来分析目标页面的 DOM 结构,并找到要捕获的信息的相关 DOM 元素。使用superagent请求目标页面的动态页面(需要运行JS的页面或者加载页面后请求界面)可以使用Nightmare模拟浏览器访问使用cheerio获取页面元素并获取目标数据完整代码爬虫完成代码GitHub地址:完整代码

后面应该有一些进阶的步骤来爬取网站上的一些好看的图片(手动搞笑),这里面会涉及到一些并发控制和反反爬虫的策略。然后使用爬虫抓取一些需要登录并输入验证码的网站。欢迎大家关注和正确沟通。

再次感谢大家的点赞、关注和评论,感谢大家的支持,谢谢!我自己认为我是一个热爱文字、音乐和编码的半文学程序员。我一直在考虑写关于技术和其他文学的文章。虽然我的基础不是那么好,但我总觉得在写文章的过程中,无论是技术还是文学,都能督促自己去思考,督促自己去学习和交流。毕竟,除了每天忙碌之外,我还要过自己不一样的生活。所以,如果以后有什么好的文章,我会积极的分享给大家!再次感谢大家的支持!

节点.js

阅读34.8k更新于2020-01-09

js 爬虫抓取网页数据(网络爬虫是一种的重要组成吗?如何解决的问题)

网站优化 • 优采云 发表了文章 • 0 个评论 • 68 次浏览 • 2022-02-03 09:32

网络爬虫是根据一定的规则自动从万维网上爬取信息的程序或脚本。网络爬虫从万维网上为搜索引擎下载网页,是搜索引擎的重要组成部分。

本文运行环境:windows10系统,thinkpad t490电脑。

网络爬虫(也称为网络蜘蛛、网络机器人,在 FOAF 社区中更常称为网络追逐者)是根据一定规则自动从万维网上爬取信息的程序或脚本。其他不太常用的名称是 ant、autoindex、emulator 或 worm。

网络爬虫是一种自动提取网页的程序。它为搜索引擎从万维网上下载网页,是搜索引擎的重要组成部分。传统爬虫从一个或多个初始网页的URL开始,获取初始网页上的URL。在对网页进行爬取的过程中,不断地从当前页面中提取新的 URL 并放入队列中,直到满足系统的某些停止条件。焦点爬虫的工作流程比较复杂。它需要按照一定的网页分析算法过滤掉与主题无关的链接,保留有用的链接,并放入等待抓取的URL队列中。然后,它会根据一定的搜索策略从队列中选择下一个要爬取的网页URL,并重复上述过程,直到系统达到一定条件并停止。此外,爬虫爬取的所有网页都会被系统存储,经过一定的分析、过滤、索引,以供后续查询和检索;对于重点爬虫来说,这个过程中得到的分析结果也可能对后续的爬取过程给出反馈和指导。

以上就是什么是网络爬虫的详细内容。更多详情请关注html中文网文章其他相关话题! 查看全部

js 爬虫抓取网页数据(网络爬虫是一种的重要组成吗?如何解决的问题)

网络爬虫是根据一定的规则自动从万维网上爬取信息的程序或脚本。网络爬虫从万维网上为搜索引擎下载网页,是搜索引擎的重要组成部分。

本文运行环境:windows10系统,thinkpad t490电脑。

网络爬虫(也称为网络蜘蛛、网络机器人,在 FOAF 社区中更常称为网络追逐者)是根据一定规则自动从万维网上爬取信息的程序或脚本。其他不太常用的名称是 ant、autoindex、emulator 或 worm。

网络爬虫是一种自动提取网页的程序。它为搜索引擎从万维网上下载网页,是搜索引擎的重要组成部分。传统爬虫从一个或多个初始网页的URL开始,获取初始网页上的URL。在对网页进行爬取的过程中,不断地从当前页面中提取新的 URL 并放入队列中,直到满足系统的某些停止条件。焦点爬虫的工作流程比较复杂。它需要按照一定的网页分析算法过滤掉与主题无关的链接,保留有用的链接,并放入等待抓取的URL队列中。然后,它会根据一定的搜索策略从队列中选择下一个要爬取的网页URL,并重复上述过程,直到系统达到一定条件并停止。此外,爬虫爬取的所有网页都会被系统存储,经过一定的分析、过滤、索引,以供后续查询和检索;对于重点爬虫来说,这个过程中得到的分析结果也可能对后续的爬取过程给出反馈和指导。

以上就是什么是网络爬虫的详细内容。更多详情请关注html中文网文章其他相关话题!

js 爬虫抓取网页数据(编辑本段影响爬行速度的一个重要因素是DNS的重要组成部分)

网站优化 • 优采云 发表了文章 • 0 个评论 • 52 次浏览 • 2022-02-02 20:13

编辑本段基本介绍

网络爬虫,也称为蜘蛛。网络爬虫是一种自动提取网页的程序,是搜索引擎的重要组成部分。作为爬虫,它是将网页尽可能多、尽可能快地交付给搜索引擎,以实现强大的数据支持。

网络爬虫通过其链接地址搜索网页,从网站的一个页面(通常是首页)开始,读取网页内容,找到网页中的其他链接地址,然后使用这些链接地址以查找下一页。一个网页,以此类推,直到这个网站的所有网页都被爬取完毕。

如果把整个互联网看成一个网站,那么网络爬虫就可以利用这个原理爬取整个互联网上的所有网页。

编辑本段爬虫系统

为了获取数亿网页,谷歌设计了分布式爬虫系统。URL 服务器向网络爬虫提供 URL 列表。每个爬虫同时维护大约 300 个网络连接。以最快的速度,使用 4 个爬虫,系统每秒可以获取超过 100 个网页。

编辑本段影响爬取速度的原因

影响爬取速度的一个重要因素是 DNS 查询,每个爬虫都维护自己的 DNS 缓冲区。这样每个连接都处于不同的状态,包括 DNS 查询、连接到主机、发送请求和获取响应。这些因素结合起来使爬虫成为一个非常复杂的系统。它通过异步输入/输出来管理事件,并通过一定数量的队列来管理获取网页过程中的状态转换。 查看全部

js 爬虫抓取网页数据(编辑本段影响爬行速度的一个重要因素是DNS的重要组成部分)

编辑本段基本介绍

网络爬虫,也称为蜘蛛。网络爬虫是一种自动提取网页的程序,是搜索引擎的重要组成部分。作为爬虫,它是将网页尽可能多、尽可能快地交付给搜索引擎,以实现强大的数据支持。

网络爬虫通过其链接地址搜索网页,从网站的一个页面(通常是首页)开始,读取网页内容,找到网页中的其他链接地址,然后使用这些链接地址以查找下一页。一个网页,以此类推,直到这个网站的所有网页都被爬取完毕。

如果把整个互联网看成一个网站,那么网络爬虫就可以利用这个原理爬取整个互联网上的所有网页。

编辑本段爬虫系统

为了获取数亿网页,谷歌设计了分布式爬虫系统。URL 服务器向网络爬虫提供 URL 列表。每个爬虫同时维护大约 300 个网络连接。以最快的速度,使用 4 个爬虫,系统每秒可以获取超过 100 个网页。

编辑本段影响爬取速度的原因

影响爬取速度的一个重要因素是 DNS 查询,每个爬虫都维护自己的 DNS 缓冲区。这样每个连接都处于不同的状态,包括 DNS 查询、连接到主机、发送请求和获取响应。这些因素结合起来使爬虫成为一个非常复杂的系统。它通过异步输入/输出来管理事件,并通过一定数量的队列来管理获取网页过程中的状态转换。

js 爬虫抓取网页数据(为什么学爬虫?机器帮助你快速爬取数据!(上))

网站优化 • 优采云 发表了文章 • 0 个评论 • 52 次浏览 • 2022-01-30 23:11

【为什么要学爬虫?] 1、爬虫很容易上手,但很难深入。如何编写一个高效的爬虫,如何编写一个高度灵活和可扩展的爬虫,是一项技术任务。另外,在爬取过程中,往往容易遇到反爬虫,比如字体反爬、IP识别、验证码等,如何一层层攻克难关,得到想要的数据,本课程,你可以学习!2、如果你是其他行业的开发者,比如app开发,web开发,学习爬虫可以加强对技术的理解,开发更安全的软件和网站【课程设计】完整的爬虫程序,无论大小,一般都可以分为三个步骤,分别是: 网络请求:模拟浏览器从互联网上抓取数据的行为。数据解析:过滤请求的数据,提取出我们想要的数据。数据存储:将提取的数据存储到硬盘或内存中。比如使用mysql数据库或者redis等。那么这门课程也是按照这些步骤一步步讲解的,带领学生全面掌握每一步的技术。此外,由于爬虫的多样性,在爬取过程中可能会出现反爬和效率低下的情况。因此我们增加了两章提高爬虫程序的灵活性,分别是: 高级爬虫:包括IP代理、多线程爬虫、图形验证码识别、JS加解密、动态网页爬虫、字体反爬识别, 等等。 。Scrapy 和分布式爬虫:Scrapy 框架,Scrapy-redis组件、分布式爬虫等。通过爬虫的高级知识,我们可以处理大量的反爬网站,而Scrapy框架作为专业的爬虫框架,可以快速提升效率和我们的爬虫程序编写速度。另外,如果一台机器不能满足你的需求,我们可以使用分布式爬虫,让多台机器帮你快速爬取数据。从基础爬虫到商业应用爬虫,这套课程满足你的所有需求!【课程服务】独家付费社区+定期问答 可以快速提高我们爬虫程序编写的效率和速度。另外,如果一台机器不能满足你的需求,我们可以使用分布式爬虫,让多台机器帮你快速爬取数据。从基础爬虫到商业应用爬虫,这套课程满足你的所有需求!【课程服务】独家付费社区+定期问答 可以快速提高我们爬虫程序编写的效率和速度。另外,如果一台机器不能满足你的需求,我们可以使用分布式爬虫,让多台机器帮你快速爬取数据。从基础爬虫到商业应用爬虫,这套课程满足你的所有需求!【课程服务】独家付费社区+定期问答 查看全部

js 爬虫抓取网页数据(为什么学爬虫?机器帮助你快速爬取数据!(上))

【为什么要学爬虫?] 1、爬虫很容易上手,但很难深入。如何编写一个高效的爬虫,如何编写一个高度灵活和可扩展的爬虫,是一项技术任务。另外,在爬取过程中,往往容易遇到反爬虫,比如字体反爬、IP识别、验证码等,如何一层层攻克难关,得到想要的数据,本课程,你可以学习!2、如果你是其他行业的开发者,比如app开发,web开发,学习爬虫可以加强对技术的理解,开发更安全的软件和网站【课程设计】完整的爬虫程序,无论大小,一般都可以分为三个步骤,分别是: 网络请求:模拟浏览器从互联网上抓取数据的行为。数据解析:过滤请求的数据,提取出我们想要的数据。数据存储:将提取的数据存储到硬盘或内存中。比如使用mysql数据库或者redis等。那么这门课程也是按照这些步骤一步步讲解的,带领学生全面掌握每一步的技术。此外,由于爬虫的多样性,在爬取过程中可能会出现反爬和效率低下的情况。因此我们增加了两章提高爬虫程序的灵活性,分别是: 高级爬虫:包括IP代理、多线程爬虫、图形验证码识别、JS加解密、动态网页爬虫、字体反爬识别, 等等。 。Scrapy 和分布式爬虫:Scrapy 框架,Scrapy-redis组件、分布式爬虫等。通过爬虫的高级知识,我们可以处理大量的反爬网站,而Scrapy框架作为专业的爬虫框架,可以快速提升效率和我们的爬虫程序编写速度。另外,如果一台机器不能满足你的需求,我们可以使用分布式爬虫,让多台机器帮你快速爬取数据。从基础爬虫到商业应用爬虫,这套课程满足你的所有需求!【课程服务】独家付费社区+定期问答 可以快速提高我们爬虫程序编写的效率和速度。另外,如果一台机器不能满足你的需求,我们可以使用分布式爬虫,让多台机器帮你快速爬取数据。从基础爬虫到商业应用爬虫,这套课程满足你的所有需求!【课程服务】独家付费社区+定期问答 可以快速提高我们爬虫程序编写的效率和速度。另外,如果一台机器不能满足你的需求,我们可以使用分布式爬虫,让多台机器帮你快速爬取数据。从基础爬虫到商业应用爬虫,这套课程满足你的所有需求!【课程服务】独家付费社区+定期问答

js 爬虫抓取网页数据(别的项目组什么项目突然心血来潮想研究一下爬虫、分析的简单原型)

网站优化 • 优采云 发表了文章 • 0 个评论 • 58 次浏览 • 2022-01-30 07:14

由于其他项目组都在做舆情预测项目,我只是手头没有项目,突然心血来潮想研究一个简单的爬虫原型和分析。网上有很多这方面的资料,看得我眼花缭乱。对于我这种新手,想做一个简单的爬虫程序,所以HttpClient + jsoup是个不错的选择。前者是用来管理请求的,后者是用来解析页面的,主要是后者的select语法和jquery很像,对我这个用js的人来说太方便了。

昨天和他们聊天时,他们使用了几个知名的开源框架。聊了几句,他们发现自己没有办法爬取动态网页,尤其是一些重要的数字,比如评论数和回复数。等等我有一个大致的了解。比如TRS的爬虫需要为js调用编写js脚本,但分析量巨大。他们的技术人员告诉我们,如果他们匹配这样的模板,他们每天只能匹配2到3个。,更何况我们这些中途修士。这恰好是一个相当大的挑战,所以我昨天答应他们,看看他们是否能找到一个相对简单的解决方案。当然,效率不是首先考虑的。

举个简单的例子,如下图

“我有话要说”后面的1307是后载的,但这些数字往往对舆情分析更重要。

对需求有了大致的了解后,我们来分析如何解决它们。通常,我们对请求得到的响应中收录js代码和html元素,所以像jsoup这样的html解析器很难在这里发挥优势,因为它所能得到的html,1307还没有生成。这时候就需要一个可以运行js的平台,运行js代码后的页面会被html解析,这样才能正确得到结果。

因为懒,一开始写脚本的方式被我抛弃了,因为分析一个页面太痛苦,代码乱成一锅粥,而且很多还用了压缩的方式,都是分别是 a(), b() 方法,太累了,看不下去了。所以我的首要任务是,为什么我不能让这个地址在某个浏览器中运行,然后将运行结果交给html解析器进行解析,那么整个问题就解决了。这样,我的临时解决方案是在爬虫服务器上打开一个后台浏览器,或者是带有浏览器内核的程序,将url地址交给它去请求,然后从浏览器中取出页面的元素并交给交给它吧。html 解析器进行解析以获取您想要的信息。

明天再说吧,先休息吧。 查看全部

js 爬虫抓取网页数据(别的项目组什么项目突然心血来潮想研究一下爬虫、分析的简单原型)

由于其他项目组都在做舆情预测项目,我只是手头没有项目,突然心血来潮想研究一个简单的爬虫原型和分析。网上有很多这方面的资料,看得我眼花缭乱。对于我这种新手,想做一个简单的爬虫程序,所以HttpClient + jsoup是个不错的选择。前者是用来管理请求的,后者是用来解析页面的,主要是后者的select语法和jquery很像,对我这个用js的人来说太方便了。

昨天和他们聊天时,他们使用了几个知名的开源框架。聊了几句,他们发现自己没有办法爬取动态网页,尤其是一些重要的数字,比如评论数和回复数。等等我有一个大致的了解。比如TRS的爬虫需要为js调用编写js脚本,但分析量巨大。他们的技术人员告诉我们,如果他们匹配这样的模板,他们每天只能匹配2到3个。,更何况我们这些中途修士。这恰好是一个相当大的挑战,所以我昨天答应他们,看看他们是否能找到一个相对简单的解决方案。当然,效率不是首先考虑的。

举个简单的例子,如下图

“我有话要说”后面的1307是后载的,但这些数字往往对舆情分析更重要。

对需求有了大致的了解后,我们来分析如何解决它们。通常,我们对请求得到的响应中收录js代码和html元素,所以像jsoup这样的html解析器很难在这里发挥优势,因为它所能得到的html,1307还没有生成。这时候就需要一个可以运行js的平台,运行js代码后的页面会被html解析,这样才能正确得到结果。

因为懒,一开始写脚本的方式被我抛弃了,因为分析一个页面太痛苦,代码乱成一锅粥,而且很多还用了压缩的方式,都是分别是 a(), b() 方法,太累了,看不下去了。所以我的首要任务是,为什么我不能让这个地址在某个浏览器中运行,然后将运行结果交给html解析器进行解析,那么整个问题就解决了。这样,我的临时解决方案是在爬虫服务器上打开一个后台浏览器,或者是带有浏览器内核的程序,将url地址交给它去请求,然后从浏览器中取出页面的元素并交给交给它吧。html 解析器进行解析以获取您想要的信息。

明天再说吧,先休息吧。

js 爬虫抓取网页数据(Python爬虫爬取动态页面思路+实例(二)实战)

网站优化 • 优采云 发表了文章 • 0 个评论 • 72 次浏览 • 2022-01-29 17:24

一、js逆向分析对于动态加载的网页,如果我们要获取网页数据,就需要了解网页是如何加载数据的。这个过程称为反向回溯。对于使用Ajax请求技术的网页,我们可以找到Ajax请求的具体链接,直接获取Ajax请求得到的数据。需要注意的是,构造 Ajax 请求有两种方式: 原生 Ajax 请求:将直接创建 XMLHTTPRequest 对象。.

在ajax横行的时代,很多网页的内容都是动态加载的,而我们的小爬虫只抓取web服务器返回给我们的html,其中。

二、实际爬虫1、先登录获取cookies网站登录,获取cookies和user-agent作为后续请求的header。设置全局变量 HEADER 以便于调用。

Python动态网站爬虫实战(requests+xpath+demjson+re博客园。

csdn为你找到了关于js动态爬虫的相关内容,包括js动态爬虫相关文档代码介绍,相关教程视频课程,以及相关js。

Python爬虫爬取动态页面思路+实例(一)博客园。

用通俗易懂的语言分享爬虫、数据分析、可视化等干货,希望大家能学到新知识。项目背景是这样的,前几个。

这时候PhantomJS+Selenium的两个神器,加上Scrapy爬虫框架,就可以拼凑成一个动态爬虫了。PhantomJS 简单地说是 PhantomJS。

对于动态加载的网页,如果要获取它的网页数据,我们需要了解网页是如何加载数据的,这个过程称为反向回溯。.

这个数据应该是动态获取的,不知道有没有合适的框架或者方法来解决这个问题。股票分级基金 全部显示。 查看全部

js 爬虫抓取网页数据(Python爬虫爬取动态页面思路+实例(二)实战)

一、js逆向分析对于动态加载的网页,如果我们要获取网页数据,就需要了解网页是如何加载数据的。这个过程称为反向回溯。对于使用Ajax请求技术的网页,我们可以找到Ajax请求的具体链接,直接获取Ajax请求得到的数据。需要注意的是,构造 Ajax 请求有两种方式: 原生 Ajax 请求:将直接创建 XMLHTTPRequest 对象。.

在ajax横行的时代,很多网页的内容都是动态加载的,而我们的小爬虫只抓取web服务器返回给我们的html,其中。

二、实际爬虫1、先登录获取cookies网站登录,获取cookies和user-agent作为后续请求的header。设置全局变量 HEADER 以便于调用。

Python动态网站爬虫实战(requests+xpath+demjson+re博客园。

csdn为你找到了关于js动态爬虫的相关内容,包括js动态爬虫相关文档代码介绍,相关教程视频课程,以及相关js。

Python爬虫爬取动态页面思路+实例(一)博客园。

用通俗易懂的语言分享爬虫、数据分析、可视化等干货,希望大家能学到新知识。项目背景是这样的,前几个。

这时候PhantomJS+Selenium的两个神器,加上Scrapy爬虫框架,就可以拼凑成一个动态爬虫了。PhantomJS 简单地说是 PhantomJS。

对于动态加载的网页,如果要获取它的网页数据,我们需要了解网页是如何加载数据的,这个过程称为反向回溯。.

这个数据应该是动态获取的,不知道有没有合适的框架或者方法来解决这个问题。股票分级基金 全部显示。

js 爬虫抓取网页数据( 简单来说,爬虫就是获取网页并提取和保存信息的自动化程序)

网站优化 • 优采云 发表了文章 • 0 个评论 • 92 次浏览 • 2022-01-28 17:19

简单来说,爬虫就是获取网页并提取和保存信息的自动化程序)

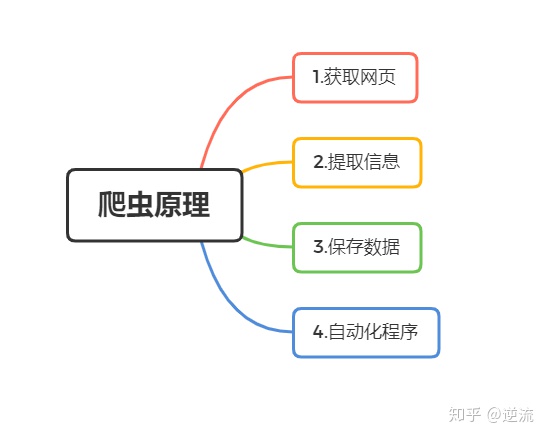

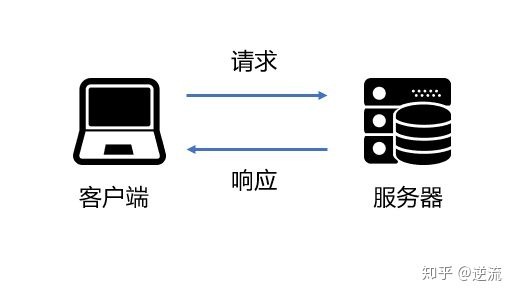

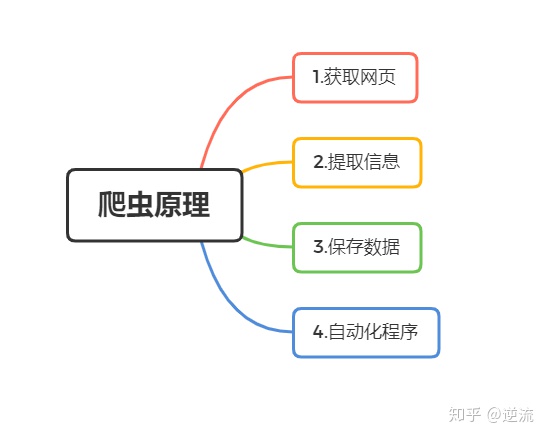

爬虫概述

简单地说,爬虫是一个自动程序,它获取网页并提取和保存信息。

爬虫可以总结为4个步骤:

1.获取网页

爬虫要做的第一个工作就是获取网页,也就是获取网页的源代码。源代码中收录了网页的一些有用信息,所以只要得到源代码,就可以从中提取出想要的信息。

根据请求和响应的概念,向网站的服务器发送一个请求,返回的响应体就是网页的源代码。因此,最关键的部分是构造一个请求并发送到服务器,然后接收响应并发送到服务器。解析出来。

Python 是实现爬虫的非常有用的工具。它提供了很多库来帮助我们实现这个操作,比如urllib、request等。我们可以使用这些库来帮助我们实现HTTP请求操作。请求和响应都可以用类库提供的数据结构来表示。得到响应后,我们只需要解析数据结构的Body部分即可。

总结:

通过python的爬虫相关库,实现HTTP请求操作,获取服务器响应,获取网页源码

2.提取信息

得到网页的源代码后,接下来就是分析网页的源代码,从中提取出我们想要的数据。通用的方法是使用正则表达式来提取。

另外,由于网页的结构有一定的规则,python也有一些基于网页节点属性、CSS选择器或者XPath来提取网页信息的库,比如Beautiful Soup、pyquery、lxml等。使用这些库,我们可以高效快速地提取网页信息,如节点属性、文本值等。

提取信息是爬虫的一个非常重要的部分。它可以从杂乱的数据中获取有效的信息,方便我们后期对数据进行处理和分析。

总结:

正则表达式是一种通用的提取方式,也可以使用一些从网页节点属性、CSS选择器等中提取信息的库,如Beautiful Soup、pyquery、lxml等。

3.保存数据

提取信息后,我们一般将提取的数据保存在某处以备后用。存储形式多样,简单处理可以保存为TXT或JSON文本。它也可以保存到 MySQL 和 MongoDB 等数据库中。或保存到远程服务器。

4.自动化程序

简单来说,爬虫可以在爬取过程中进行各种异常处理、错误重试等操作,持续高效地完成获取网页、提取信息、保存数据等工作。

爬虫可以抓取什么样的数据

[1] 最常见的爬取是 HTML 源代码。

[2] JSON字符串,有些网页返回JSON字符串而不是HTML代码,特别是API接口多采用这种形式,这种格式的数据易于传输和解析,也可以被抓取,数据提取更方便。

[3] 爬虫可以抓取图片、视频、音频等二进制数据,并保存为对应的文件名。

[4] 各种扩展文件,例如 CSS、JavaScript 和配置文件。

页面的 JavaScript 渲染

有时候,当我们使用 urllib 或者 request 爬取一个网页时,得到的源码其实和我们在浏览器中看到的不一样。

这是一个非常普遍的问题。因为越来越多的网页是用 Ajax 和前端模块化工具构建的,所以整个网页可能都是用 JavaScript 渲染的,也就是说原来的 HTML 代码只是一个空壳。

例如下面的 HTML 代码

This is a Demo

body节点中只有一个id为container的节点,但是在body节点之后引入了app.js,负责整个网站的渲染。

过程是在浏览器中打开页面时,先加载HTML内容,然后浏览器会找到那个app。代码,JavaScript 更改 HTML 中的节点,向它们添加内容,最后呈现完整的页面。

当我们请求一个带有 urllib 或 request 等库的页面时,我们得到的只是这个 HTML 代码,它不会帮助我们加载这个 JavaScript 文件,所以我们在浏览器中看不到内容。

对于这样的情况,我们可以分析它的后台Ajax接口,或者使用Selenium、Splash等库来模拟JavaScript渲染,后面会介绍。

本文总结参考《Python3网络爬虫开发实战》 查看全部

js 爬虫抓取网页数据(

简单来说,爬虫就是获取网页并提取和保存信息的自动化程序)

爬虫概述

简单地说,爬虫是一个自动程序,它获取网页并提取和保存信息。

爬虫可以总结为4个步骤:

1.获取网页

爬虫要做的第一个工作就是获取网页,也就是获取网页的源代码。源代码中收录了网页的一些有用信息,所以只要得到源代码,就可以从中提取出想要的信息。

根据请求和响应的概念,向网站的服务器发送一个请求,返回的响应体就是网页的源代码。因此,最关键的部分是构造一个请求并发送到服务器,然后接收响应并发送到服务器。解析出来。

Python 是实现爬虫的非常有用的工具。它提供了很多库来帮助我们实现这个操作,比如urllib、request等。我们可以使用这些库来帮助我们实现HTTP请求操作。请求和响应都可以用类库提供的数据结构来表示。得到响应后,我们只需要解析数据结构的Body部分即可。

总结:

通过python的爬虫相关库,实现HTTP请求操作,获取服务器响应,获取网页源码

2.提取信息

得到网页的源代码后,接下来就是分析网页的源代码,从中提取出我们想要的数据。通用的方法是使用正则表达式来提取。

另外,由于网页的结构有一定的规则,python也有一些基于网页节点属性、CSS选择器或者XPath来提取网页信息的库,比如Beautiful Soup、pyquery、lxml等。使用这些库,我们可以高效快速地提取网页信息,如节点属性、文本值等。

提取信息是爬虫的一个非常重要的部分。它可以从杂乱的数据中获取有效的信息,方便我们后期对数据进行处理和分析。

总结:

正则表达式是一种通用的提取方式,也可以使用一些从网页节点属性、CSS选择器等中提取信息的库,如Beautiful Soup、pyquery、lxml等。

3.保存数据

提取信息后,我们一般将提取的数据保存在某处以备后用。存储形式多样,简单处理可以保存为TXT或JSON文本。它也可以保存到 MySQL 和 MongoDB 等数据库中。或保存到远程服务器。

4.自动化程序

简单来说,爬虫可以在爬取过程中进行各种异常处理、错误重试等操作,持续高效地完成获取网页、提取信息、保存数据等工作。

爬虫可以抓取什么样的数据

[1] 最常见的爬取是 HTML 源代码。

[2] JSON字符串,有些网页返回JSON字符串而不是HTML代码,特别是API接口多采用这种形式,这种格式的数据易于传输和解析,也可以被抓取,数据提取更方便。

[3] 爬虫可以抓取图片、视频、音频等二进制数据,并保存为对应的文件名。

[4] 各种扩展文件,例如 CSS、JavaScript 和配置文件。

页面的 JavaScript 渲染

有时候,当我们使用 urllib 或者 request 爬取一个网页时,得到的源码其实和我们在浏览器中看到的不一样。

这是一个非常普遍的问题。因为越来越多的网页是用 Ajax 和前端模块化工具构建的,所以整个网页可能都是用 JavaScript 渲染的,也就是说原来的 HTML 代码只是一个空壳。

例如下面的 HTML 代码

This is a Demo

body节点中只有一个id为container的节点,但是在body节点之后引入了app.js,负责整个网站的渲染。

过程是在浏览器中打开页面时,先加载HTML内容,然后浏览器会找到那个app。代码,JavaScript 更改 HTML 中的节点,向它们添加内容,最后呈现完整的页面。

当我们请求一个带有 urllib 或 request 等库的页面时,我们得到的只是这个 HTML 代码,它不会帮助我们加载这个 JavaScript 文件,所以我们在浏览器中看不到内容。

对于这样的情况,我们可以分析它的后台Ajax接口,或者使用Selenium、Splash等库来模拟JavaScript渲染,后面会介绍。

本文总结参考《Python3网络爬虫开发实战》

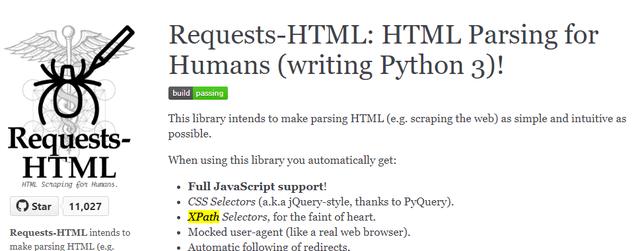

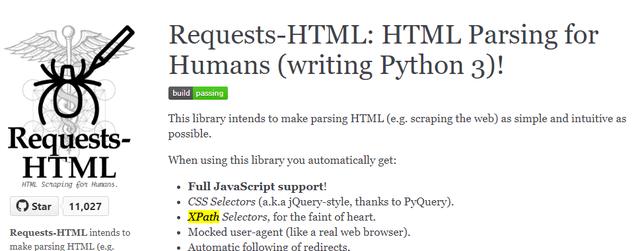

js 爬虫抓取网页数据(Python最简单的爬虫requests-html安装-)

网站优化 • 优采云 发表了文章 • 0 个评论 • 57 次浏览 • 2022-01-28 17:17

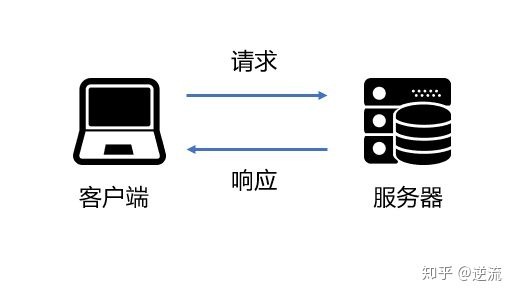

很多朋友都听说过Python这个名字,Python也有很多爬虫框架,其中最简单的就是requests-html。它与著名的网络请求库 requests 是同一作者。它专注于XML数据提取,可以说是最简单的爬虫框架。

安装请求-html

安装这个类库很简单,可以直接通过pip安装。

pip install requests-html

开始使用

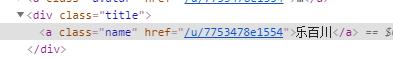

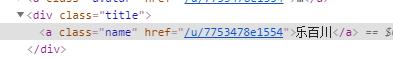

requests-html 使用起来也很简单,这里举个简单的例子。和往常一样,第一段介绍 HTMLSession 创建连接并获取网页数据。第二段创建连接,获取我的简书用户页面。第三段使用xpath语法获取网页上的用户名,最后打印出来。

from requests_html import HTMLSessionsession = HTMLSession()response = session.get( 'https://www.jianshu.com/u/7753478e1554')username = response.html.xpath( '//a[@class="name"]/text()', first=True)print(username)

看起来很简单吗?是的,它真的很简单,而且还有一些更有趣的功能。

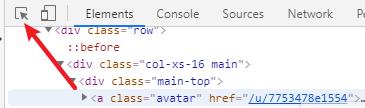

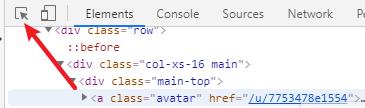

分析网页

在编写爬虫之前要做的另一件事是分析网页的结构。这个工作其实很简单,打开你要访问的网页,按F12打开开发者工具,在最左边就可以看到这样一个按钮。点击这个按钮,然后在网页上点击你要查看的网页元素,你可以发现已经为你定位到了该元素对应的相关源码。

定位按钮

通过这个功能,我们可以很方便的分析网页,然后根据它的结构编写爬虫。

提取数据

上面的response.html是网页根节点的HTML节点,可以在节点对象上调用一些方法来获取数据。最常用的方法是 find 方法,它通过 CSS 选择器来定位数据。对于上面的例子,第三段可以用 find 方法重写。

由于所有搜索方法都返回列表,如果您确定只需要搜索一个,请将第一个参数设置为 true 以仅返回第一个结果。find 方法仍然返回一个节点。如果只需要节点的内容,可以调用它的 text 属性。

用户名对应的HTML结构如图所示。

代码显示如下。

username = response.html.find('a.name', first=True).text

除了 find 方法,您还可以使用 xpath 方法使用 xpath 语法查找节点,如第一个示例所示。我个人更喜欢 xpath 语法。虽然 CSS 选择器比较流行,但是写出来的效果有点怪,不像 xpath 那样整洁。

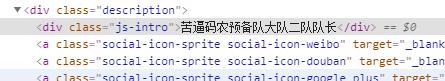

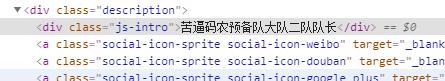

同样在此页面上,查看如何获取我的简要资料。网页代码如图所示。

代码显示如下。

description = response.html.xpath( '//div[@class="description"]/div[@class="js-intro"]/text()', first=True)

CSS 选择器和 XPATH 语法不是本文的主要内容,如果你不熟悉这方面,最好去相关教程。当然,如果你有任何问题,你可以问他们。如果你想看,我也可以专门写一个文章来介绍这些语法知识。

呈现网页

有些网页是使用前后端分离技术开发的,需要浏览器渲染才能完整显示。如果用爬虫看的话,只能显示部分内容。这时,浏览器需要渲染页面才能获得完整的页面。使用 requests-html,过程非常简单。

我们先来看一个需要渲染网页的例子。下面的代码访问我的简书用户页面,然后尝试获取我所有的 文章s。但是如果你运行这个例子,你会发现只获取了前几个项目。因为简书页面是典型的需要浏览器渲染的页面,爬虫获取到的网页是不完整的。

from requests_html import HTMLSessionsession = HTMLSession()headers = { 'user-agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/83.0.4103.119 Safari/537.36'}url = 'https://www.jianshu.com/u/7753478e1554'r = session.get(url, headers=headers)for a in r.html.xpath('//ul[@class="note-list"]/li/div[@class="content"]/a[@class="title"]'): title = a.text link = f'https://www.jianshu.com{a.attrs["href"]}' print(f'《{title}》,{link}')

那么如何渲染网页以获得完整的结果呢?其实很简单,在查询HTML节点之前调用render函数即可。

使用浏览器渲染的渲染函数

原理也很简单。当第一次调用 render 时,requests-html 会在本地下载一个 chromium 浏览器并使用它来渲染网页。这样,我们就可以得到渲染后的页面了。

但是对于简书的例子还是有一些问题,因为如果你在浏览器中打开这个页面,你会发现有些文章在浏览器向下滑动页面的时候开始渲染。不过,聪明的作者早就考虑到了这种情况。render函数支持滑动参数。设置后会模拟浏览器滑动操作,从而解决这个问题。

r.html.render(scrolldown=50, sleep=0.2)

节点对象

不管上面的 r.html 还是 find/xpath 函数返回的结果,都是节点对象。除了上面介绍的提取数据的方法外,节点对象还有以下几个属性,在我们提取数据的时候也是非常有用的。

相比scrapy这个专业的爬虫框架,或者BeautifulSoup,一个只用来解析XML的解析库。requests-html可以说是恰到好处,没有前者那么难学,也不需要像后者那样配合HTTP请求库使用。如果你需要临时爬取手头的几个页面,requests-html 是你最好的选择。 查看全部

js 爬虫抓取网页数据(Python最简单的爬虫requests-html安装-)

很多朋友都听说过Python这个名字,Python也有很多爬虫框架,其中最简单的就是requests-html。它与著名的网络请求库 requests 是同一作者。它专注于XML数据提取,可以说是最简单的爬虫框架。

安装请求-html

安装这个类库很简单,可以直接通过pip安装。

pip install requests-html

开始使用

requests-html 使用起来也很简单,这里举个简单的例子。和往常一样,第一段介绍 HTMLSession 创建连接并获取网页数据。第二段创建连接,获取我的简书用户页面。第三段使用xpath语法获取网页上的用户名,最后打印出来。

from requests_html import HTMLSessionsession = HTMLSession()response = session.get( 'https://www.jianshu.com/u/7753478e1554')username = response.html.xpath( '//a[@class="name"]/text()', first=True)print(username)

看起来很简单吗?是的,它真的很简单,而且还有一些更有趣的功能。

分析网页

在编写爬虫之前要做的另一件事是分析网页的结构。这个工作其实很简单,打开你要访问的网页,按F12打开开发者工具,在最左边就可以看到这样一个按钮。点击这个按钮,然后在网页上点击你要查看的网页元素,你可以发现已经为你定位到了该元素对应的相关源码。

定位按钮

通过这个功能,我们可以很方便的分析网页,然后根据它的结构编写爬虫。

提取数据

上面的response.html是网页根节点的HTML节点,可以在节点对象上调用一些方法来获取数据。最常用的方法是 find 方法,它通过 CSS 选择器来定位数据。对于上面的例子,第三段可以用 find 方法重写。

由于所有搜索方法都返回列表,如果您确定只需要搜索一个,请将第一个参数设置为 true 以仅返回第一个结果。find 方法仍然返回一个节点。如果只需要节点的内容,可以调用它的 text 属性。

用户名对应的HTML结构如图所示。

代码显示如下。

username = response.html.find('a.name', first=True).text

除了 find 方法,您还可以使用 xpath 方法使用 xpath 语法查找节点,如第一个示例所示。我个人更喜欢 xpath 语法。虽然 CSS 选择器比较流行,但是写出来的效果有点怪,不像 xpath 那样整洁。

同样在此页面上,查看如何获取我的简要资料。网页代码如图所示。

代码显示如下。

description = response.html.xpath( '//div[@class="description"]/div[@class="js-intro"]/text()', first=True)

CSS 选择器和 XPATH 语法不是本文的主要内容,如果你不熟悉这方面,最好去相关教程。当然,如果你有任何问题,你可以问他们。如果你想看,我也可以专门写一个文章来介绍这些语法知识。

呈现网页

有些网页是使用前后端分离技术开发的,需要浏览器渲染才能完整显示。如果用爬虫看的话,只能显示部分内容。这时,浏览器需要渲染页面才能获得完整的页面。使用 requests-html,过程非常简单。

我们先来看一个需要渲染网页的例子。下面的代码访问我的简书用户页面,然后尝试获取我所有的 文章s。但是如果你运行这个例子,你会发现只获取了前几个项目。因为简书页面是典型的需要浏览器渲染的页面,爬虫获取到的网页是不完整的。

from requests_html import HTMLSessionsession = HTMLSession()headers = { 'user-agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/83.0.4103.119 Safari/537.36'}url = 'https://www.jianshu.com/u/7753478e1554'r = session.get(url, headers=headers)for a in r.html.xpath('//ul[@class="note-list"]/li/div[@class="content"]/a[@class="title"]'): title = a.text link = f'https://www.jianshu.com{a.attrs["href"]}' print(f'《{title}》,{link}')

那么如何渲染网页以获得完整的结果呢?其实很简单,在查询HTML节点之前调用render函数即可。

使用浏览器渲染的渲染函数

原理也很简单。当第一次调用 render 时,requests-html 会在本地下载一个 chromium 浏览器并使用它来渲染网页。这样,我们就可以得到渲染后的页面了。

但是对于简书的例子还是有一些问题,因为如果你在浏览器中打开这个页面,你会发现有些文章在浏览器向下滑动页面的时候开始渲染。不过,聪明的作者早就考虑到了这种情况。render函数支持滑动参数。设置后会模拟浏览器滑动操作,从而解决这个问题。

r.html.render(scrolldown=50, sleep=0.2)

节点对象

不管上面的 r.html 还是 find/xpath 函数返回的结果,都是节点对象。除了上面介绍的提取数据的方法外,节点对象还有以下几个属性,在我们提取数据的时候也是非常有用的。

相比scrapy这个专业的爬虫框架,或者BeautifulSoup,一个只用来解析XML的解析库。requests-html可以说是恰到好处,没有前者那么难学,也不需要像后者那样配合HTTP请求库使用。如果你需要临时爬取手头的几个页面,requests-html 是你最好的选择。

js 爬虫抓取网页数据(获取数据网页内容获取多个网页内容头部获取网页内容)

网站优化 • 优采云 发表了文章 • 0 个评论 • 72 次浏览 • 2022-01-28 17:17

检索数据

前面已经描述了整个过程。现在获取数据,首先获取一个URL的网页内容,然后获取多个网页内容。

获取标头标头:

按F12,然后找到Network,找到Doc,按F5刷新,然后按左上角的红色按钮停止取值,将鼠标拖到开头,点击后会有关于请求的信息,点击它,并且在Department User-Agent的末尾会有一个标题。

获取 URL 的 Web 内容:

#得到指定一个URL的网页内容

def askURL(url):

#模拟浏览器头部信息,向服务器发送消息

head={"User-Agent":"Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/70.0.3538.25 Safari/537.36 Core/1.70.3775.400 QQBrowser/10.6.4208.400"}

#用户代理‘表示告诉服务器,我门是什么类型的机器、浏览器

request = urllib.request.Request(url,headers=head)

html = ''

try:

response = urllib.request.urlopen(request)

html = response.read().decode("utf-8")

print(html)

except urllib.error.URLError as e:

if hasattr(e,"code"):

print(e.code)

if hasattr(e,"reason"):

print(e.reason)

return html

if __name__=="__main__":

#调用函数

askURL("https://movie.douban.com/top250?statrt=1")

注意:使用 try 是异常处理。

获取多个网页内容:

这是使用循环的时候了。

def main():

baseurl='https://movie.douban.com/top250?statrt=i'

#爬取网页

datalist=getData(baseurl)

def getData(baseurl):

datalist=[]

for i in range(0,10): #调用获取页面信息的函数,10次

url = baseurl+str(i*25)

html = askURL(url) #保存获取到的网页源码

#2.逐一解析数据

return datalist

现在只获取网页的内容,不进行解析。需要更多的知识来扩展。 查看全部

js 爬虫抓取网页数据(获取数据网页内容获取多个网页内容头部获取网页内容)

检索数据

前面已经描述了整个过程。现在获取数据,首先获取一个URL的网页内容,然后获取多个网页内容。

获取标头标头:

按F12,然后找到Network,找到Doc,按F5刷新,然后按左上角的红色按钮停止取值,将鼠标拖到开头,点击后会有关于请求的信息,点击它,并且在Department User-Agent的末尾会有一个标题。

获取 URL 的 Web 内容:

#得到指定一个URL的网页内容

def askURL(url):

#模拟浏览器头部信息,向服务器发送消息

head={"User-Agent":"Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/70.0.3538.25 Safari/537.36 Core/1.70.3775.400 QQBrowser/10.6.4208.400"}

#用户代理‘表示告诉服务器,我门是什么类型的机器、浏览器

request = urllib.request.Request(url,headers=head)

html = ''

try:

response = urllib.request.urlopen(request)

html = response.read().decode("utf-8")

print(html)

except urllib.error.URLError as e:

if hasattr(e,"code"):

print(e.code)

if hasattr(e,"reason"):

print(e.reason)

return html

if __name__=="__main__":

#调用函数

askURL("https://movie.douban.com/top250?statrt=1";)

注意:使用 try 是异常处理。

获取多个网页内容:

这是使用循环的时候了。

def main():

baseurl='https://movie.douban.com/top250?statrt=i'

#爬取网页

datalist=getData(baseurl)

def getData(baseurl):

datalist=[]

for i in range(0,10): #调用获取页面信息的函数,10次

url = baseurl+str(i*25)

html = askURL(url) #保存获取到的网页源码

#2.逐一解析数据

return datalist

现在只获取网页的内容,不进行解析。需要更多的知识来扩展。

js 爬虫抓取网页数据(1.岗位列表的第一页(图)代码分析(组图) )

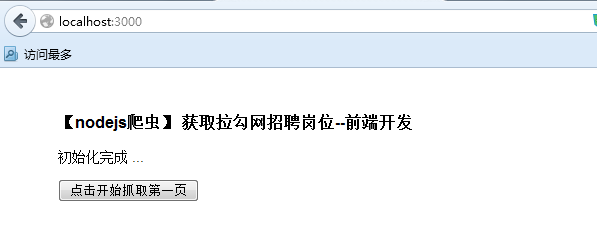

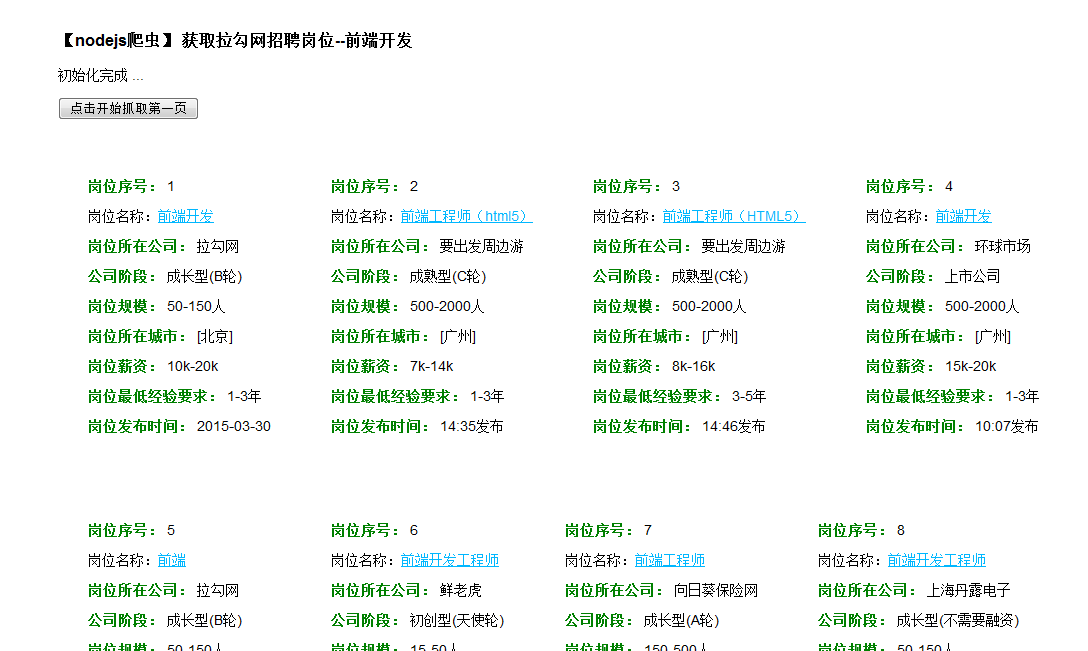

网站优化 • 优采云 发表了文章 • 0 个评论 • 67 次浏览 • 2022-01-25 15:14

)

爬虫之类的东西我之前一直都听说过,不过稍微看了一下资料,好像也不算太复杂。

只知道node.js,然后基于它做一个简单的爬虫。

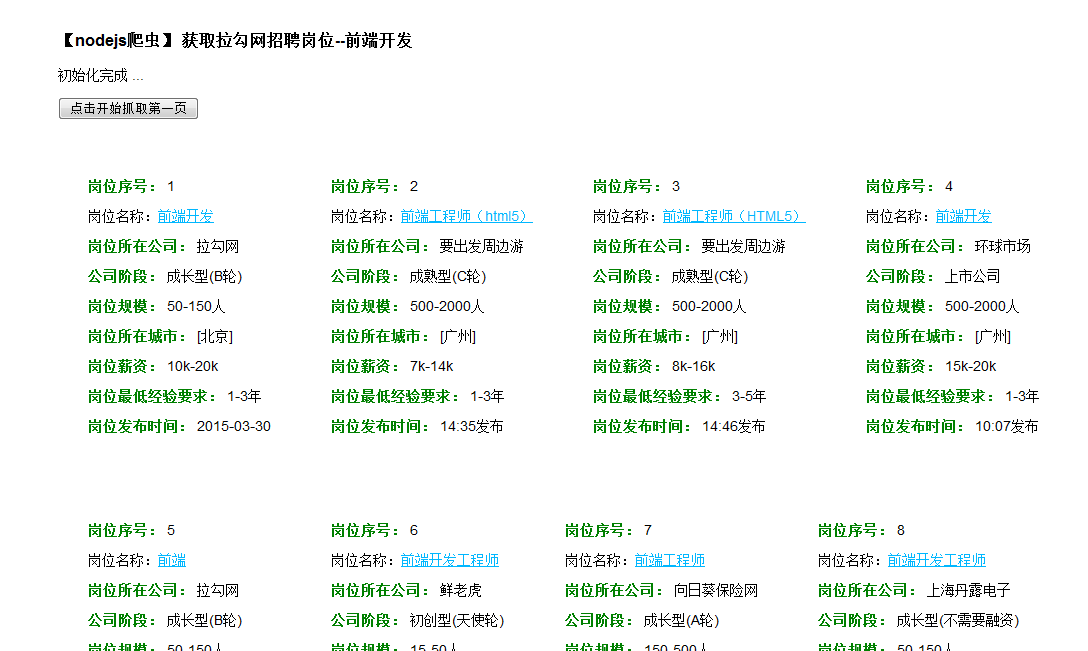

1.这个爬虫目标:

从钩子招聘网站中找出“前端开发”职位的信息,分析对应页面,提取职位名称、职位薪资、职位所属公司等具体部分,发布日期等。并显示捕获的信息。

初始hook网站的接口信息如下:

2.设计方案:

爬虫实际上是通过相应的技术来爬取页面上的具体信息。

在这里,我们主要抓取上图所示职位列表部分相关的具体职位信息。

首先,要爬取,首先要有地址url:

%E5%89%8D%E7%AB%AF%E5%BC%80%E5%8F%91?kd=%E5%89%8D%E7%AB%AF%E5%BC%80%E5%8F% 91&spc=1&pl=&gj=&xl=&yx=&gx=&st=&labelWords=label&lc=&workAddress=&city=%E5%85%A8%E5%9B%BD&requestId=&pn=1

此链接是职位列表首页的网址。

通过分析地址的参数部分,我们忽略了选择的其他参数,只看最后一个参数值:pn=1

我们的目的是逐页抓取,所以设置为 pn = page;

其次,要获取特定信息,爬虫需要特定代表的标识符。

这里对页面代码的tag值、class值、id值进行分析。

通过 Firebug 审查这个小子集的元素

确定将获得什么信息的分析需要处理特定的标识符。

3.代码编写:

按照预定的计划,考虑到node.js的使用,通过其内置的http模块获取页面信息,通过cheerio.js模块分析DOM,然后转换成json格式的数据,直接从控制台输出或者将json数据再次发送回浏览器显示。

(cheerio.js的使用很简单,可以自行搜索详情。最重要的是下面的代码,其余的和jQuery的使用类似。

就是先加载页面的数据,形成特定的数据格式,然后通过类似jq的语法解析数据)

var cheerio = require('cheerio'),

$ = cheerio.load('Hello world');

$('h2.title').text('Hello there!');

$('h2').addClass('welcome');

$.html();

//=> Hello there!

采用快速模块化开发,项目建立后按要求。进入项目目录,执行 npm install 安装所需的依赖。不知道快递的可以看这里

爬虫需要cheerio.js,所以另外需要进来,所以另外npm installcheerio

有很多项目文件。为简单起见,仅对其中三个进行了修改。(index.ejs index.js style.css)

(1)直接修改routes路由中的index.js文件,也是核心部分。

看代码吧,注释已经够多了

1 var express = require('express');

2 var router = express.Router();

3 var http = require('http');

4 var cheerio = require('cheerio');

5

6 /* GET home page. */

7 router.get('/', function(req, res, next) {

8 res.render('index', { title: '简单nodejs爬虫' });

9 });

10 router.get('/getJobs', function(req, res, next) { // 浏览器端发来get请求

11 var page = req.param('page'); //获取get请求中的参数 page

12 console.log("page: "+page);

13 var Res = res; //保存,防止下边的修改

14 //url 获取信息的页面部分地址

15 var url = 'http://www.lagou.com/jobs/list_%E5%89%8D%E7%AB%AF%E5%BC%80%E5%8F%91?kd=%E5%89%8D%E7%AB%AF%E5%BC%80%E5%8F%91&spc=1&pl=&gj=&xl=&yx=&gx=&st=&labelWords=label&lc=&workAddress=&city=%E5%85%A8%E5%9B%BD&requestId=&pn=';

16

17 http.get(url+page,function(res){ //通过get方法获取对应地址中的页面信息

18 var chunks = [];

19 var size = 0;

20 res.on('data',function(chunk){ //监听事件 传输

21 chunks.push(chunk);

22 size += chunk.length;

23 });

24 res.on('end',function(){ //数据传输完

25 var data = Buffer.concat(chunks,size);

26 var html = data.toString();

27 // console.log(html);

28 var $ = cheerio.load(html); //cheerio模块开始处理 DOM处理

29 var jobs = [];

30

31 var jobs_list = $(".hot_pos li");

32 $(".hot_pos>li").each(function(){ //对页面岗位栏信息进行处理 每个岗位对应一个 li ,各标识符到页面进行分析得出

33 var job = {};

34 job.company = $(this).find(".hot_pos_r div").eq(1).find("a").html(); //公司名

35 job.period = $(this).find(".hot_pos_r span").eq(1).html(); //阶段

36 job.scale = $(this).find(".hot_pos_r span").eq(2).html(); //规模

37

38 job.name = $(this).find(".hot_pos_l a").attr("title"); //岗位名

39 job.src = $(this).find(".hot_pos_l a").attr("href"); //岗位链接

40 job.city = $(this).find(".hot_pos_l .c9").html(); //岗位所在城市

41 job.salary = $(this).find(".hot_pos_l span").eq(1).html(); //薪资

42 job.exp = $(this).find(".hot_pos_l span").eq(2).html(); //岗位所需经验

43 job.time = $(this).find(".hot_pos_l span").eq(5).html(); //发布时间

44

45 console.log(job.name); //控制台输出岗位名

46 jobs.push(job);

47 });

48 Res.json({ //返回json格式数据给浏览器端

49 jobs:jobs

50 });

51 });

52 });

53

54 });

55

56 module.exports = router;

(2)node.js捕获的核心代码就是上面的部分。

下一步是展示抓取的数据,所以需要另外一个页面来修改views中的index.ejs模板

1 DOCTYPE html>

2

3

4

5

6

7

8 【nodejs爬虫】 获取拉勾网招聘岗位--前端开发

9 初始化完成 ...

10 点击开始抓取第一页

11

12

13

14

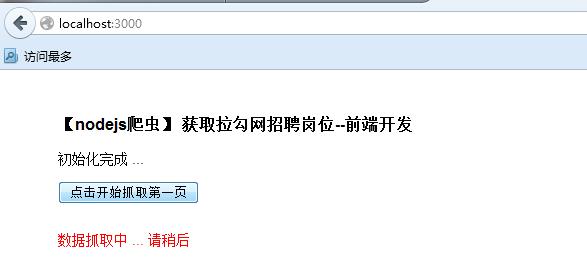

15 数据抓取中 ... 请稍后

16 抓取上一页

17 抓取下一页

18

19

20

21 function getData(str){ //获取到的数据有杂乱..需要把前面部分去掉,只需要data(...... data)

22 if(str){

23 return str.slice(str.lastIndexOf(">")+1);

24 }

25 }

26

27 document.getElementById("btn1").style.visibility = "hidden";

28 document.getElementById("btn2").style.visibility = "hidden";

29 var currentPage = 0; //page初始0

30

31 function cheerFetch(_page){ //抓取数据处理函数

32 if(_page == 1){

33 currentPage = 1; //开始抓取则更改page

34 }

35 $(document).ajaxSend(function(event, xhr, settings) { //抓取中...

36 $(".fetching").css("display","block");

37 });

38 $(document).ajaxSuccess(function(event, xhr, settings) { //抓取成功

39 $(".fetching").css("display","none");

40 });

41 $.ajax({ //开始发送ajax请求至路径 /getJobs 进而作页面抓取处理

42 data:{page:_page}, //参数 page = _page

43 dataType: "json",

44 type: "get",

45 url: "/getJobs",

46 success: function(data){ //收到返回的json数据

47 console.log(data);

48 var html = "";

49 $(".container").empty();

50 if(data.jobs.length == 0){

51 alert("Error2: 未找到数据..");

52 return;

53 }

54 for(var i=0;i 1){

73 document.getElementById("btn1").style.visibility = "visible";

74 document.getElementById("btn2").style.visibility = "visible";

75 }

76 },

77 error: function(){

78 alert("Error1: 未找到数据..");

79 }

80 });

81 }

82

83

84

85

(3)当然,对public文件下的style.css进行简单的修改也是style部分不可缺少的

body {

padding: 20px 50px;

font: 14px "Lucida Grande", Helvetica, Arial, sans-serif;

}

a {

color: #00B7FF;

cursor: pointer;

}

.container{position: relative;width: 1100px;overflow: hidden;zoom:1;}

.jobs{margin: 30px; float: left;}

.jobs span{ color: green; font-weight: bold;}

.btn{cursor: pointer;}

.fetching{display: none;color: red;}

.footer{clear: both;}

基本的变化就是这三个文件。

因此,如果要进行测试,可以在新建项目后直接修改对应的三个文件。

修改成功后,就可以测试了。

3.测试结果

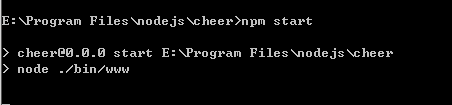

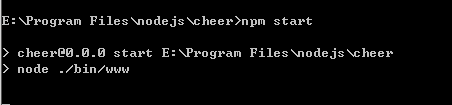

1) 先在控制台执行 npm start

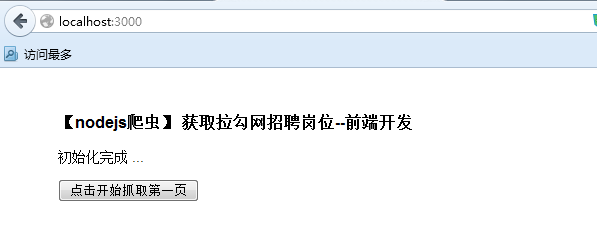

2) 接下来在浏览器中输入:3000/开始访问

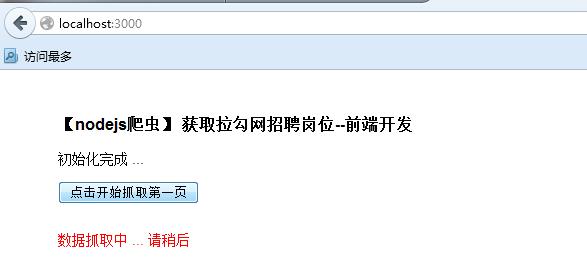

3) 点击开始爬取(这里每次抓取15个项目,即原创URL对应15个项目)

...

查看全部

js 爬虫抓取网页数据(1.岗位列表的第一页(图)代码分析(组图)

)

爬虫之类的东西我之前一直都听说过,不过稍微看了一下资料,好像也不算太复杂。

只知道node.js,然后基于它做一个简单的爬虫。

1.这个爬虫目标:

从钩子招聘网站中找出“前端开发”职位的信息,分析对应页面,提取职位名称、职位薪资、职位所属公司等具体部分,发布日期等。并显示捕获的信息。

初始hook网站的接口信息如下:

2.设计方案:

爬虫实际上是通过相应的技术来爬取页面上的具体信息。

在这里,我们主要抓取上图所示职位列表部分相关的具体职位信息。

首先,要爬取,首先要有地址url:

%E5%89%8D%E7%AB%AF%E5%BC%80%E5%8F%91?kd=%E5%89%8D%E7%AB%AF%E5%BC%80%E5%8F% 91&spc=1&pl=&gj=&xl=&yx=&gx=&st=&labelWords=label&lc=&workAddress=&city=%E5%85%A8%E5%9B%BD&requestId=&pn=1

此链接是职位列表首页的网址。

通过分析地址的参数部分,我们忽略了选择的其他参数,只看最后一个参数值:pn=1

我们的目的是逐页抓取,所以设置为 pn = page;

其次,要获取特定信息,爬虫需要特定代表的标识符。

这里对页面代码的tag值、class值、id值进行分析。

通过 Firebug 审查这个小子集的元素

确定将获得什么信息的分析需要处理特定的标识符。

3.代码编写:

按照预定的计划,考虑到node.js的使用,通过其内置的http模块获取页面信息,通过cheerio.js模块分析DOM,然后转换成json格式的数据,直接从控制台输出或者将json数据再次发送回浏览器显示。

(cheerio.js的使用很简单,可以自行搜索详情。最重要的是下面的代码,其余的和jQuery的使用类似。

就是先加载页面的数据,形成特定的数据格式,然后通过类似jq的语法解析数据)

var cheerio = require('cheerio'),

$ = cheerio.load('Hello world');

$('h2.title').text('Hello there!');

$('h2').addClass('welcome');

$.html();

//=> Hello there!

采用快速模块化开发,项目建立后按要求。进入项目目录,执行 npm install 安装所需的依赖。不知道快递的可以看这里

爬虫需要cheerio.js,所以另外需要进来,所以另外npm installcheerio

有很多项目文件。为简单起见,仅对其中三个进行了修改。(index.ejs index.js style.css)

(1)直接修改routes路由中的index.js文件,也是核心部分。

看代码吧,注释已经够多了

1 var express = require('express');

2 var router = express.Router();

3 var http = require('http');

4 var cheerio = require('cheerio');

5

6 /* GET home page. */

7 router.get('/', function(req, res, next) {

8 res.render('index', { title: '简单nodejs爬虫' });

9 });

10 router.get('/getJobs', function(req, res, next) { // 浏览器端发来get请求

11 var page = req.param('page'); //获取get请求中的参数 page

12 console.log("page: "+page);

13 var Res = res; //保存,防止下边的修改

14 //url 获取信息的页面部分地址

15 var url = 'http://www.lagou.com/jobs/list_%E5%89%8D%E7%AB%AF%E5%BC%80%E5%8F%91?kd=%E5%89%8D%E7%AB%AF%E5%BC%80%E5%8F%91&spc=1&pl=&gj=&xl=&yx=&gx=&st=&labelWords=label&lc=&workAddress=&city=%E5%85%A8%E5%9B%BD&requestId=&pn=';

16

17 http.get(url+page,function(res){ //通过get方法获取对应地址中的页面信息

18 var chunks = [];

19 var size = 0;

20 res.on('data',function(chunk){ //监听事件 传输

21 chunks.push(chunk);

22 size += chunk.length;

23 });

24 res.on('end',function(){ //数据传输完

25 var data = Buffer.concat(chunks,size);

26 var html = data.toString();

27 // console.log(html);

28 var $ = cheerio.load(html); //cheerio模块开始处理 DOM处理

29 var jobs = [];

30

31 var jobs_list = $(".hot_pos li");

32 $(".hot_pos>li").each(function(){ //对页面岗位栏信息进行处理 每个岗位对应一个 li ,各标识符到页面进行分析得出

33 var job = {};

34 job.company = $(this).find(".hot_pos_r div").eq(1).find("a").html(); //公司名

35 job.period = $(this).find(".hot_pos_r span").eq(1).html(); //阶段

36 job.scale = $(this).find(".hot_pos_r span").eq(2).html(); //规模

37

38 job.name = $(this).find(".hot_pos_l a").attr("title"); //岗位名

39 job.src = $(this).find(".hot_pos_l a").attr("href"); //岗位链接

40 job.city = $(this).find(".hot_pos_l .c9").html(); //岗位所在城市

41 job.salary = $(this).find(".hot_pos_l span").eq(1).html(); //薪资

42 job.exp = $(this).find(".hot_pos_l span").eq(2).html(); //岗位所需经验

43 job.time = $(this).find(".hot_pos_l span").eq(5).html(); //发布时间

44

45 console.log(job.name); //控制台输出岗位名

46 jobs.push(job);

47 });

48 Res.json({ //返回json格式数据给浏览器端

49 jobs:jobs

50 });

51 });

52 });

53

54 });

55

56 module.exports = router;

(2)node.js捕获的核心代码就是上面的部分。

下一步是展示抓取的数据,所以需要另外一个页面来修改views中的index.ejs模板

1 DOCTYPE html>

2

3

4

5

6

7

8 【nodejs爬虫】 获取拉勾网招聘岗位--前端开发

9 初始化完成 ...

10 点击开始抓取第一页

11

12

13

14

15 数据抓取中 ... 请稍后

16 抓取上一页

17 抓取下一页

18

19

20

21 function getData(str){ //获取到的数据有杂乱..需要把前面部分去掉,只需要data(...... data)

22 if(str){

23 return str.slice(str.lastIndexOf(">")+1);

24 }

25 }

26

27 document.getElementById("btn1").style.visibility = "hidden";

28 document.getElementById("btn2").style.visibility = "hidden";

29 var currentPage = 0; //page初始0

30

31 function cheerFetch(_page){ //抓取数据处理函数

32 if(_page == 1){

33 currentPage = 1; //开始抓取则更改page

34 }

35 $(document).ajaxSend(function(event, xhr, settings) { //抓取中...

36 $(".fetching").css("display","block");

37 });

38 $(document).ajaxSuccess(function(event, xhr, settings) { //抓取成功

39 $(".fetching").css("display","none");

40 });

41 $.ajax({ //开始发送ajax请求至路径 /getJobs 进而作页面抓取处理

42 data:{page:_page}, //参数 page = _page

43 dataType: "json",

44 type: "get",

45 url: "/getJobs",

46 success: function(data){ //收到返回的json数据

47 console.log(data);

48 var html = "";

49 $(".container").empty();

50 if(data.jobs.length == 0){

51 alert("Error2: 未找到数据..");

52 return;

53 }

54 for(var i=0;i 1){

73 document.getElementById("btn1").style.visibility = "visible";

74 document.getElementById("btn2").style.visibility = "visible";

75 }

76 },

77 error: function(){

78 alert("Error1: 未找到数据..");

79 }

80 });

81 }

82

83

84

85

(3)当然,对public文件下的style.css进行简单的修改也是style部分不可缺少的

body {

padding: 20px 50px;

font: 14px "Lucida Grande", Helvetica, Arial, sans-serif;

}

a {

color: #00B7FF;

cursor: pointer;

}

.container{position: relative;width: 1100px;overflow: hidden;zoom:1;}

.jobs{margin: 30px; float: left;}

.jobs span{ color: green; font-weight: bold;}

.btn{cursor: pointer;}

.fetching{display: none;color: red;}

.footer{clear: both;}

基本的变化就是这三个文件。

因此,如果要进行测试,可以在新建项目后直接修改对应的三个文件。

修改成功后,就可以测试了。

3.测试结果

1) 先在控制台执行 npm start

2) 接下来在浏览器中输入:3000/开始访问

3) 点击开始爬取(这里每次抓取15个项目,即原创URL对应15个项目)

...

js 爬虫抓取网页数据(Node学习之cheerio网络爬虫好了,啊哈哈哈~昨天的抓取博文)

网站优化 • 优采云 发表了文章 • 0 个评论 • 60 次浏览 • 2022-01-21 21:01

书接上上一本,哈哈,昨天出版了,如何使用Node的cheerio模块抓取网页信息,那我们获取数据一定要有自己的用处。

昨天抓了几张超诱人的糕点,今天给大家看,大家都馋了啊哈哈哈~

昨天的爬虫博文,有需要的请点此链接:Node Learning Cheerio Web Crawler

好,我们开始今天的演示,上代码:

<p>var http = require("http");

var cheerio = require("cheerio");

//准备抓取的网站链接

var dataUrl = "http://www.mcake.com/shop/110/ ... 3B%3B

http.get(dataUrl,function(res){

var str = "";

//绑定方法,获取网页数据

res.on("data",function(chunk){

str += chunk;

})

//数据获取完毕

res.on("end",function(){

//调用下方的函数,得到返回值,即是我们想要的img的src

var data = getData(str);

//console.log(data);

----------

//新添加的部分

//用node搭建服务器,将内容展示在页面上