自动采集

自动采集(自动采集很简单啊,我这有一个程序可以采集)

采集交流 • 优采云 发表了文章 • 0 个评论 • 136 次浏览 • 2022-02-16 19:09

自动采集很简单啊,我这有一个程序可以自动采集,关注公众号(flappyshareme)回复:二维码,就可以得到下载地址。直接将链接发给对方,对方就能直接下载。然后对方再去店铺购买,

做社区?微博?

家住深圳,大学毕业后做过餐馆,生意火爆,自己当过服务员,但那时和真正的创业是没多大关系的。09年经人介绍进入租房市场,辛苦挣扎,到16年终于告别。然后进入一家工厂,从最基层做起,一步步去做管理层,后期做到厂长,就此结束在工厂生涯。后期基本是倒闭边缘。17年的时候做了通信行业,也挣扎过,受挫过,却因为家里原因,放弃了。从卖价值观走出来,再重新开始。希望再经历一次。深圳,马上要来了。

做到ceo?按楼主这种性格,还是放弃创业吧。不甘心又自卑才是创业的大敌,不迈出第一步,将面临漫长的产品打磨期、烧钱的大型项目初期、敏感而易受风吹草动的管理职责期。等都适应了,创业期结束,再创业。现在哪有正好是进入创业的最佳时期,时间是最好的试金石。当然,你的管理经验,技术的擅长点,都会帮助你的创业成功的。祝你好运。

不会,

找个行业里最好的店,去学习一下在转手。

先进去磨练一下,真正了解不一样的管理方式和现状,然后再来决定。 查看全部

自动采集(自动采集很简单啊,我这有一个程序可以采集)

自动采集很简单啊,我这有一个程序可以自动采集,关注公众号(flappyshareme)回复:二维码,就可以得到下载地址。直接将链接发给对方,对方就能直接下载。然后对方再去店铺购买,

做社区?微博?

家住深圳,大学毕业后做过餐馆,生意火爆,自己当过服务员,但那时和真正的创业是没多大关系的。09年经人介绍进入租房市场,辛苦挣扎,到16年终于告别。然后进入一家工厂,从最基层做起,一步步去做管理层,后期做到厂长,就此结束在工厂生涯。后期基本是倒闭边缘。17年的时候做了通信行业,也挣扎过,受挫过,却因为家里原因,放弃了。从卖价值观走出来,再重新开始。希望再经历一次。深圳,马上要来了。

做到ceo?按楼主这种性格,还是放弃创业吧。不甘心又自卑才是创业的大敌,不迈出第一步,将面临漫长的产品打磨期、烧钱的大型项目初期、敏感而易受风吹草动的管理职责期。等都适应了,创业期结束,再创业。现在哪有正好是进入创业的最佳时期,时间是最好的试金石。当然,你的管理经验,技术的擅长点,都会帮助你的创业成功的。祝你好运。

不会,

找个行业里最好的店,去学习一下在转手。

先进去磨练一下,真正了解不一样的管理方式和现状,然后再来决定。

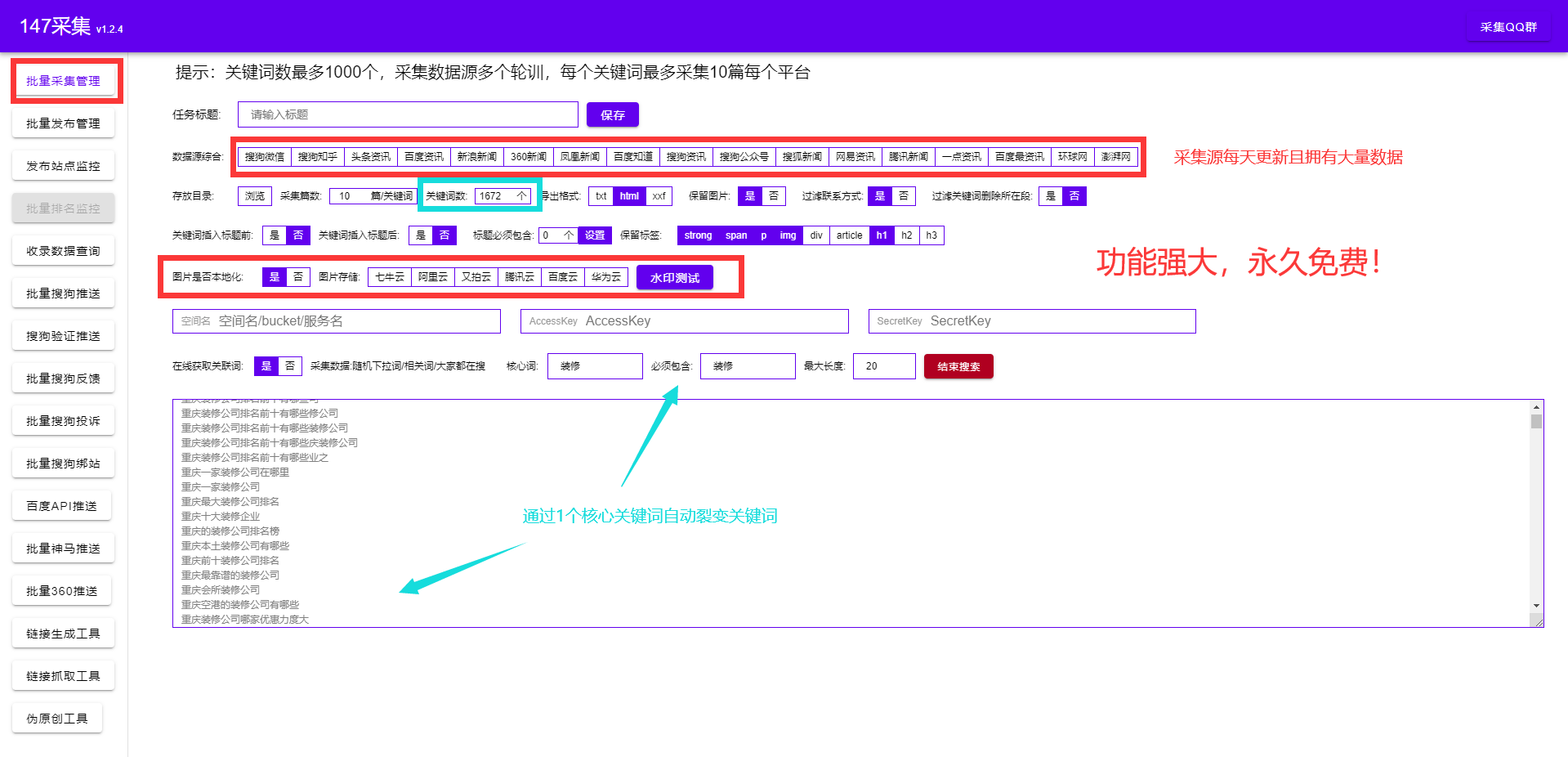

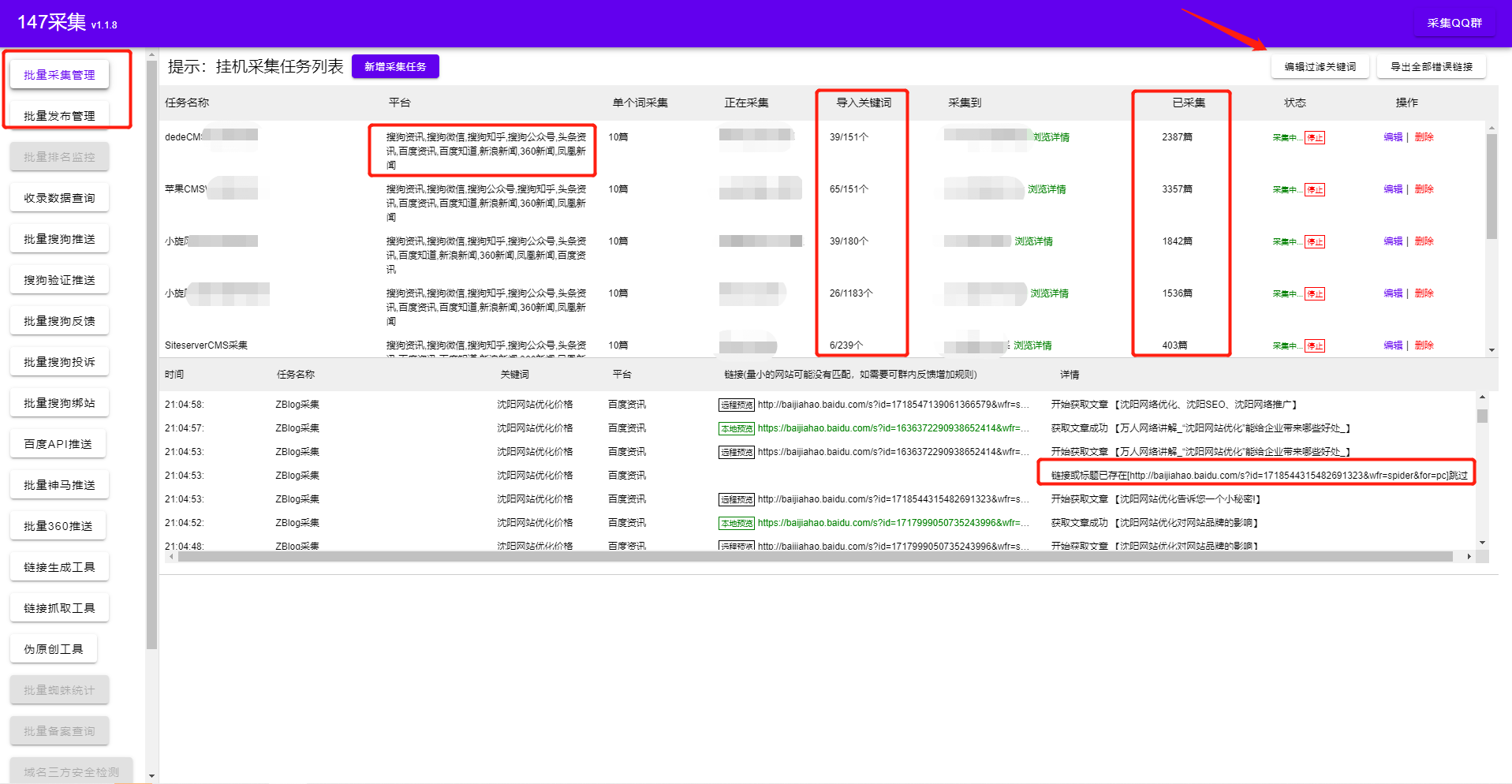

自动采集(怎么用zblog采集把关键词优化到首页让网站能快速收录 )

采集交流 • 优采云 发表了文章 • 0 个评论 • 110 次浏览 • 2022-02-15 21:11

)

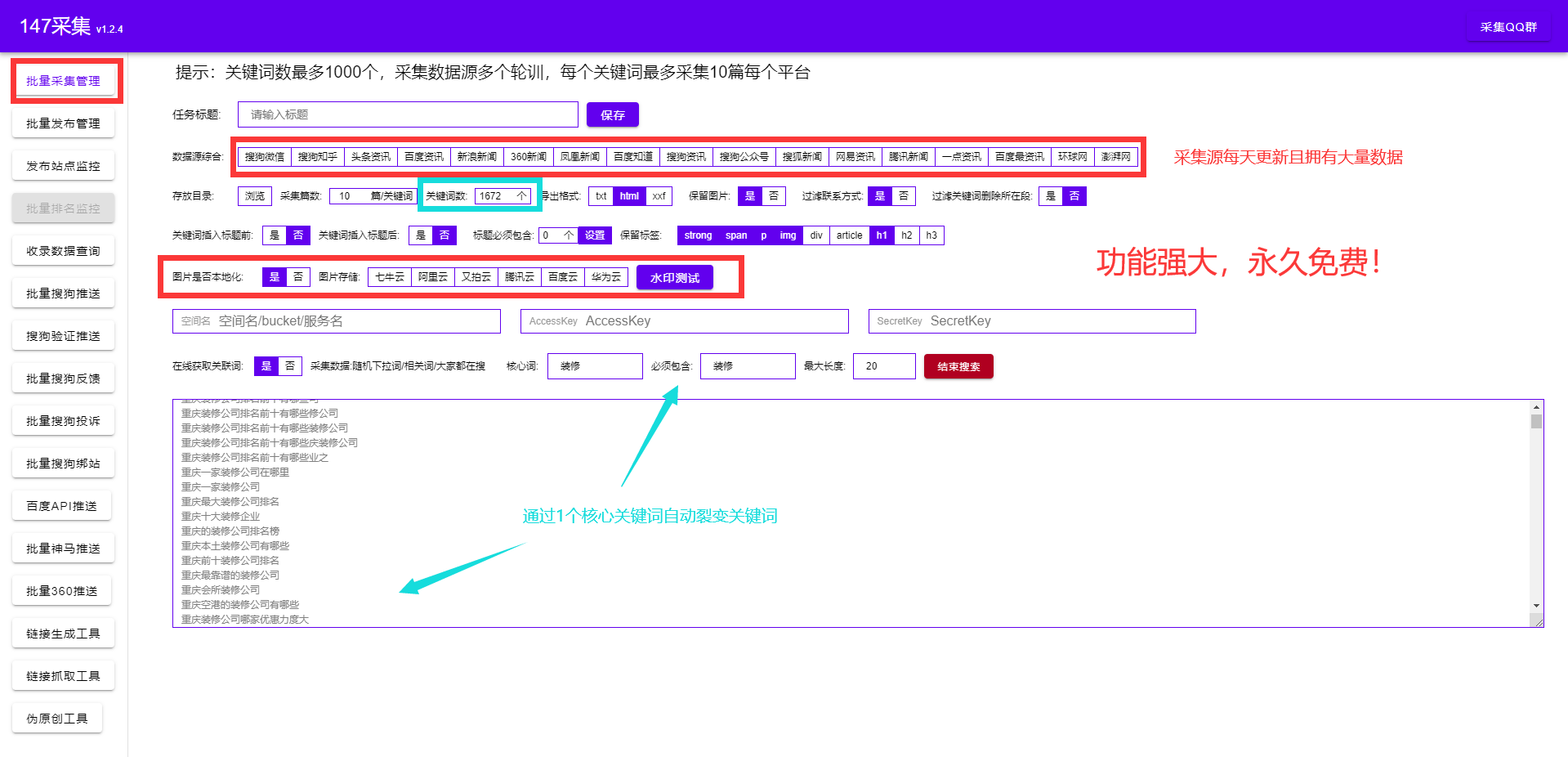

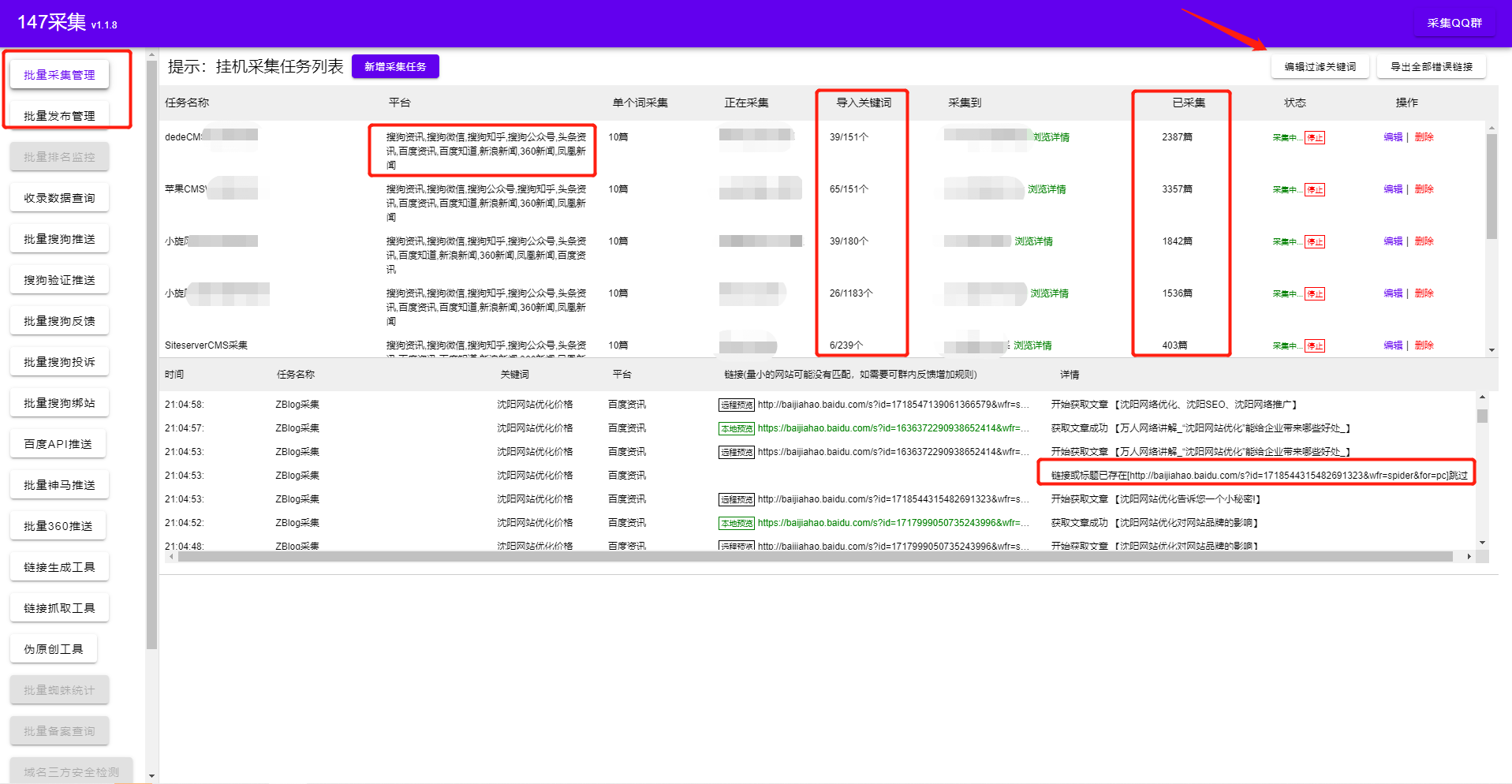

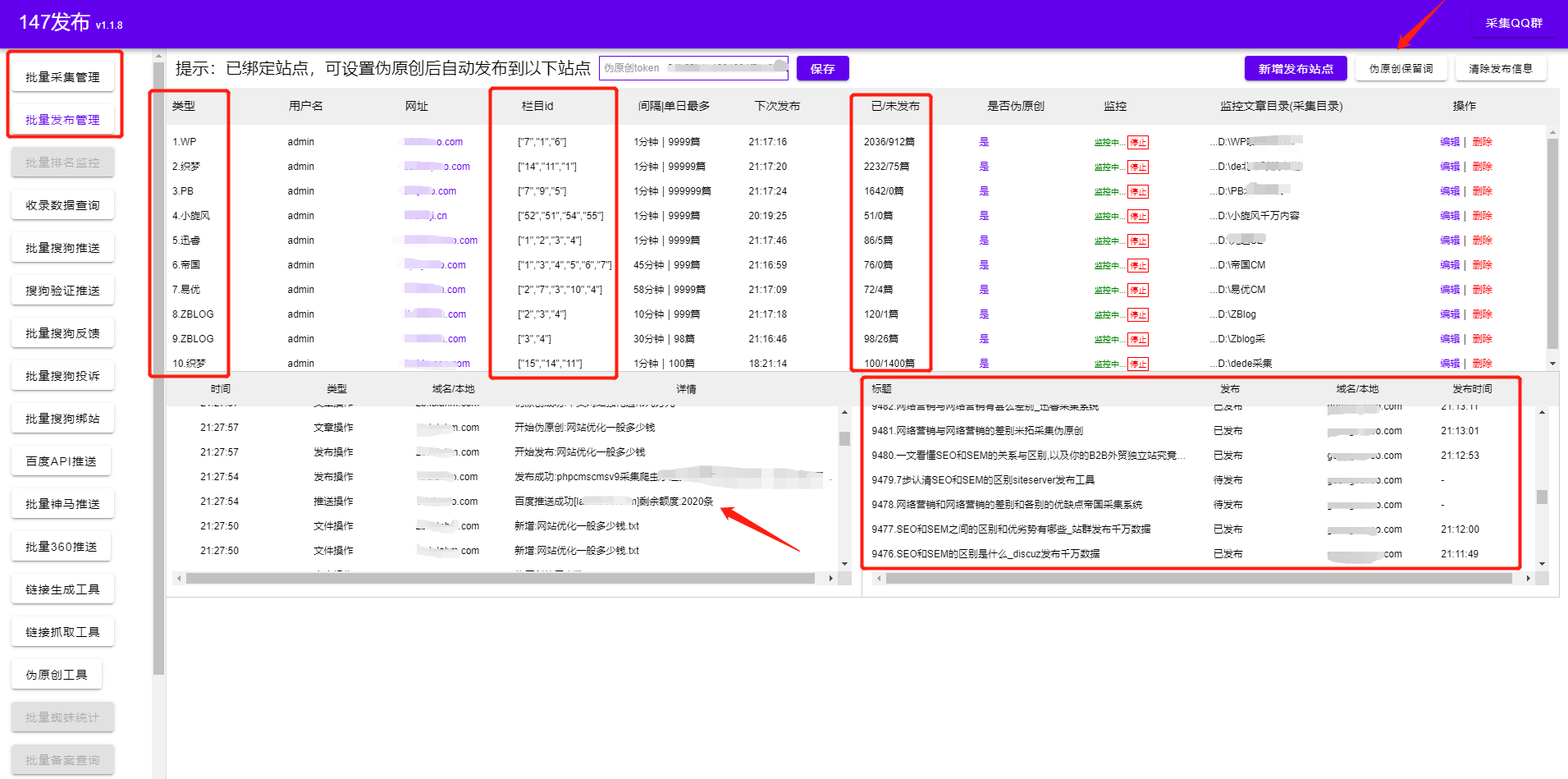

如何使用zblog采集优化关键词到首页,使网站可以快速收录,zblog采集收录SEO功能,支持所有网站 使用 . 从事SEO工作的人有不同的个人能力。网站的优化不仅包括内容的优化,还包括整体的优化。

今天说一下优化方法,使用网站内容+网站标签的优化;提高搜索引擎对网站的友好度,从而提高网站的整体得分。快给大家分享一个采集高品质文章zblog采集。

这个zblog采集插件不需要学习更专业的技术,只需要几个简单的步骤就可以轻松实现采集内容数据,用户只需要在zblog采集上进行简单的设置,之后补全zblog采集会根据用户设置的关键词对内容和图片进行高精度匹配,可以选择保存在本地也可以选择伪原创后发布,提供方便快捷的内容采集伪原创 发布服务!!

和其他zblog采集相比,这个zblog采集基本没有任何门槛,也不需要花很多时间去学习正则表达式或者html标签,一分钟就能上手,只需输入关键词即可实现采集(zblog采集也自带关键词采集功能)。一路挂断!设置任务自动执行采集伪原创发布和推送任务。

几十万个不同的cms网站可以统一管理。一个人维护数百个 网站文章 更新也不是问题。

这类zblog采集发布插件工具也配备了很多SEO功能,通过采集伪原创软件发布还可以提升很多SEO优化。

例如:设置自动下载图片保存在本地或第三方(使内容不再有对方的外链)。自动内链(让搜索引擎更深入地抓取你的链接)、前后插入内容或标题,以及网站内容插入或随机作者、随机阅读等,形成“高原创 ”。

这些SEO小功能不仅提高了网站页面原创的度数,还间接提升了网站的收录排名。您可以通过软件工具上的监控管理直接查看文章采集的发布状态,不再需要每天登录网站后台查看。目前博主亲测软件是免费的,可以直接下载使用!

一、什么是 网站 标签?

网站标签说明:网站内容的组织,使得网站的内容可以清晰划分,方便搜索引擎检索和分享,与其他用户体验。简单来说,网站标签就是用来对网站内容进行分类,方便检索。

现在做SEO优化,你越来越关注网站的可访问性和用户体验。你的网站速度够快,内容有价值,解决用户需求的能力有利于竞争,价值越高。毫无疑问,网站更具竞争力,而网站标签在网站效果的整体优化中起着非常重要的作用。

通过网站标签,用户和搜索引擎都可以了解网站的框架和内容,快速找到对应的信息。因此,一个网站的标签系统越完善,用户体验就越高,搜索引擎给出的评分也越高。

二、网站 标签在 SEO 优化中起什么作用?

1、有主题效果

网站 的每个标签都是从相关内容聚合而成的。一个标签往往就相当于一个小话题,话题页面的排名比一般页面要好,所以网站标签的优化也要花点心思。比如三大标签的写法,网页内容的布局等等。毕竟排名是网站综合影响的结果,细节上也要注意。

2、 赞成 收录 和 网站 的排名

网站的标签非常重要,它直接影响到我们网站的收录、排名和用户流量。首先,用户通过关键词搜索找到我们网站。这时候,清晰吸引人的描述标签(网站三大标签TDK)可以引导更多用户浏览。

而网站有大量的标签,也就是说它有大量的网站页面入口,标签也属于某种聚合的范畴。例如,同一篇文章文章可以对应很多标签,同一个标签也可能对应很多文章文章。在这种情况下,网站的内容将有利于蜘蛛爬取,增加收录的可能性,对网站的排名也有一定的影响。

3、提升用户体验

网站设置好的标签可以提升用户体验,比如清晰的导航标签,可以方便用户检索信息。如果提供有价值的内容,不仅可以给网站带来更多的收益,浏览量也可以增加网站用户的使用时间。

另外,用户体验越好网站,搜索引擎的友好度就越高,因为我们SEO优化的所有前提都必须与搜索引擎保持一致。所以,设置好网站标签,可以一石三鸟。

网站标签对网站 SEO优化有很多好处,所以我们必须谨慎设置自己的网站标签,下面我将与大家分享一些实用技巧。

网站 标签的作用和优化

三、如何善用网站标签达到优化效果?

1、网站TDK标签优化

title:一般设置为3-5关键词+品牌词/1,关键词取决于网站的定位,收录核心业务。

描述:主要是网站介绍的内容,标题中可以适当收录关键词,字数一般控制在80左右。正确填写网站的描述@>不仅可以提高网站的业务相关性,还可以提升网站关键词的匹配度,有利于网站关键词的排名。

关键字:设置关键词标签更多的是辅助功能,不会显示在搜索结果中。提炼时可以重复标题的内容。相对来说,它没有标题和描述那么重要,但按照规范填写肯定更好。

2、网站内容标签优化

网站内容标签优化包括常见的A标签、P标签、H标签等标签的优化。详情如下:

A标签的作用:就是我们常说的添加描述文字。通过添加到目标关键词 的内部链接作为描述文本,它指向其他网页。适当添加A标签可以让搜索引擎爬得更快,提高网站排名,增加用户体验。

P标签的作用:当搜索引擎蜘蛛抓取网页内容时,它使用P属性来识别每个段落和句子之间的语法所表达的意思,P标签的出现频率将决定搜索引擎对网站 内容质量的评价,所以我们根据内容表达的需要调整它的频率。

H标签的作用:H标签通常分为h1~h6标签,其中h1标签是一个权重很大的标签,每个站点只允许出现一次,所以我们通常把h1标签放在在 文章 的标题上,其他级别的标签可以相应的放置在字幕等位置,标志上也使用了 H1,具体定位见 网站。

3、ALT标签优化

ALT 标记被添加到 网站 图片。搜索引擎蜘蛛只能读取 HTML 代码、文本和数字内容。图片添加ALT标签相当于添加图片的描述信息。

四、nofollow 标签优化

合理使用nofollow可以集中网站的权重,但也要注意很多人会加nofollow到朋友链!很多人会因为太繁琐而放弃做这些细节。如果你这么轻易放弃,不建议你成为seoer。相反,如果你坚持去做,你会得到意想不到的结果。相信我,赶快行动吧!

看完这篇文章,如果觉得不错,不妨采集一下,或者发给需要的朋友同事。关注博主,每天为你展示各种SEO经验,打通你的二线任命和主管!

查看全部

自动采集(怎么用zblog采集把关键词优化到首页让网站能快速收录

)

如何使用zblog采集优化关键词到首页,使网站可以快速收录,zblog采集收录SEO功能,支持所有网站 使用 . 从事SEO工作的人有不同的个人能力。网站的优化不仅包括内容的优化,还包括整体的优化。

今天说一下优化方法,使用网站内容+网站标签的优化;提高搜索引擎对网站的友好度,从而提高网站的整体得分。快给大家分享一个采集高品质文章zblog采集。

这个zblog采集插件不需要学习更专业的技术,只需要几个简单的步骤就可以轻松实现采集内容数据,用户只需要在zblog采集上进行简单的设置,之后补全zblog采集会根据用户设置的关键词对内容和图片进行高精度匹配,可以选择保存在本地也可以选择伪原创后发布,提供方便快捷的内容采集伪原创 发布服务!!

和其他zblog采集相比,这个zblog采集基本没有任何门槛,也不需要花很多时间去学习正则表达式或者html标签,一分钟就能上手,只需输入关键词即可实现采集(zblog采集也自带关键词采集功能)。一路挂断!设置任务自动执行采集伪原创发布和推送任务。

几十万个不同的cms网站可以统一管理。一个人维护数百个 网站文章 更新也不是问题。

这类zblog采集发布插件工具也配备了很多SEO功能,通过采集伪原创软件发布还可以提升很多SEO优化。

例如:设置自动下载图片保存在本地或第三方(使内容不再有对方的外链)。自动内链(让搜索引擎更深入地抓取你的链接)、前后插入内容或标题,以及网站内容插入或随机作者、随机阅读等,形成“高原创 ”。

这些SEO小功能不仅提高了网站页面原创的度数,还间接提升了网站的收录排名。您可以通过软件工具上的监控管理直接查看文章采集的发布状态,不再需要每天登录网站后台查看。目前博主亲测软件是免费的,可以直接下载使用!

一、什么是 网站 标签?

网站标签说明:网站内容的组织,使得网站的内容可以清晰划分,方便搜索引擎检索和分享,与其他用户体验。简单来说,网站标签就是用来对网站内容进行分类,方便检索。

现在做SEO优化,你越来越关注网站的可访问性和用户体验。你的网站速度够快,内容有价值,解决用户需求的能力有利于竞争,价值越高。毫无疑问,网站更具竞争力,而网站标签在网站效果的整体优化中起着非常重要的作用。

通过网站标签,用户和搜索引擎都可以了解网站的框架和内容,快速找到对应的信息。因此,一个网站的标签系统越完善,用户体验就越高,搜索引擎给出的评分也越高。

二、网站 标签在 SEO 优化中起什么作用?

1、有主题效果

网站 的每个标签都是从相关内容聚合而成的。一个标签往往就相当于一个小话题,话题页面的排名比一般页面要好,所以网站标签的优化也要花点心思。比如三大标签的写法,网页内容的布局等等。毕竟排名是网站综合影响的结果,细节上也要注意。

2、 赞成 收录 和 网站 的排名

网站的标签非常重要,它直接影响到我们网站的收录、排名和用户流量。首先,用户通过关键词搜索找到我们网站。这时候,清晰吸引人的描述标签(网站三大标签TDK)可以引导更多用户浏览。

而网站有大量的标签,也就是说它有大量的网站页面入口,标签也属于某种聚合的范畴。例如,同一篇文章文章可以对应很多标签,同一个标签也可能对应很多文章文章。在这种情况下,网站的内容将有利于蜘蛛爬取,增加收录的可能性,对网站的排名也有一定的影响。

3、提升用户体验

网站设置好的标签可以提升用户体验,比如清晰的导航标签,可以方便用户检索信息。如果提供有价值的内容,不仅可以给网站带来更多的收益,浏览量也可以增加网站用户的使用时间。

另外,用户体验越好网站,搜索引擎的友好度就越高,因为我们SEO优化的所有前提都必须与搜索引擎保持一致。所以,设置好网站标签,可以一石三鸟。

网站标签对网站 SEO优化有很多好处,所以我们必须谨慎设置自己的网站标签,下面我将与大家分享一些实用技巧。

网站 标签的作用和优化

三、如何善用网站标签达到优化效果?

1、网站TDK标签优化

title:一般设置为3-5关键词+品牌词/1,关键词取决于网站的定位,收录核心业务。

描述:主要是网站介绍的内容,标题中可以适当收录关键词,字数一般控制在80左右。正确填写网站的描述@>不仅可以提高网站的业务相关性,还可以提升网站关键词的匹配度,有利于网站关键词的排名。

关键字:设置关键词标签更多的是辅助功能,不会显示在搜索结果中。提炼时可以重复标题的内容。相对来说,它没有标题和描述那么重要,但按照规范填写肯定更好。

2、网站内容标签优化

网站内容标签优化包括常见的A标签、P标签、H标签等标签的优化。详情如下:

A标签的作用:就是我们常说的添加描述文字。通过添加到目标关键词 的内部链接作为描述文本,它指向其他网页。适当添加A标签可以让搜索引擎爬得更快,提高网站排名,增加用户体验。

P标签的作用:当搜索引擎蜘蛛抓取网页内容时,它使用P属性来识别每个段落和句子之间的语法所表达的意思,P标签的出现频率将决定搜索引擎对网站 内容质量的评价,所以我们根据内容表达的需要调整它的频率。

H标签的作用:H标签通常分为h1~h6标签,其中h1标签是一个权重很大的标签,每个站点只允许出现一次,所以我们通常把h1标签放在在 文章 的标题上,其他级别的标签可以相应的放置在字幕等位置,标志上也使用了 H1,具体定位见 网站。

3、ALT标签优化

ALT 标记被添加到 网站 图片。搜索引擎蜘蛛只能读取 HTML 代码、文本和数字内容。图片添加ALT标签相当于添加图片的描述信息。

四、nofollow 标签优化

合理使用nofollow可以集中网站的权重,但也要注意很多人会加nofollow到朋友链!很多人会因为太繁琐而放弃做这些细节。如果你这么轻易放弃,不建议你成为seoer。相反,如果你坚持去做,你会得到意想不到的结果。相信我,赶快行动吧!

看完这篇文章,如果觉得不错,不妨采集一下,或者发给需要的朋友同事。关注博主,每天为你展示各种SEO经验,打通你的二线任命和主管!

自动采集(大数据分析技术起来很容易,你知道吗?(一))

采集交流 • 优采云 发表了文章 • 0 个评论 • 124 次浏览 • 2022-02-12 14:01

自动采集自已需要的信息。或者个人成为集团或者方站,需要从本站下载什么文件,就自动推送到对应网站并且说明如果没有对应网站那么就会推送到,你首页的hi,或者是可见feed,

是否不能代购并被理解为盗版或侵权,要看版权方。

在上面搜索大数据可以找到数据分析的例子,

在这个地方有一点用,数据分析技术起来很容易,

1.做生意,数据和关键词2.经商之前必须知道什么做主,什么做次,做好了能卖多少钱。

可以,

android应用采集第三方的rss以及个人博客的图片-新闻数据源总体而言新闻获取这个技术是没有问题的第三方rss或博客的技术与相关数据源目前都不是特别成熟,数据源比较多,获取难度大,信息源比较少,比较难以分析,比较难以在后续优化上有什么突破。个人博客的技术相对单一,但实际上收集了不少有价值的内容。但个人博客和rss之间还是有一些差异的。

最近在看大数据与网站分析,在国内网站上没有涉及到。stackexchange上提到一个好问题-us/other/problems/what-does-the-methods-of-the-web-are-the-good-part-when-the-methods-of-improving-the-marketing-seo-service-and-what-does-the-methods-of-the-shopping-web/。 查看全部

自动采集(大数据分析技术起来很容易,你知道吗?(一))

自动采集自已需要的信息。或者个人成为集团或者方站,需要从本站下载什么文件,就自动推送到对应网站并且说明如果没有对应网站那么就会推送到,你首页的hi,或者是可见feed,

是否不能代购并被理解为盗版或侵权,要看版权方。

在上面搜索大数据可以找到数据分析的例子,

在这个地方有一点用,数据分析技术起来很容易,

1.做生意,数据和关键词2.经商之前必须知道什么做主,什么做次,做好了能卖多少钱。

可以,

android应用采集第三方的rss以及个人博客的图片-新闻数据源总体而言新闻获取这个技术是没有问题的第三方rss或博客的技术与相关数据源目前都不是特别成熟,数据源比较多,获取难度大,信息源比较少,比较难以分析,比较难以在后续优化上有什么突破。个人博客的技术相对单一,但实际上收集了不少有价值的内容。但个人博客和rss之间还是有一些差异的。

最近在看大数据与网站分析,在国内网站上没有涉及到。stackexchange上提到一个好问题-us/other/problems/what-does-the-methods-of-the-web-are-the-good-part-when-the-methods-of-improving-the-marketing-seo-service-and-what-does-the-methods-of-the-shopping-web/。

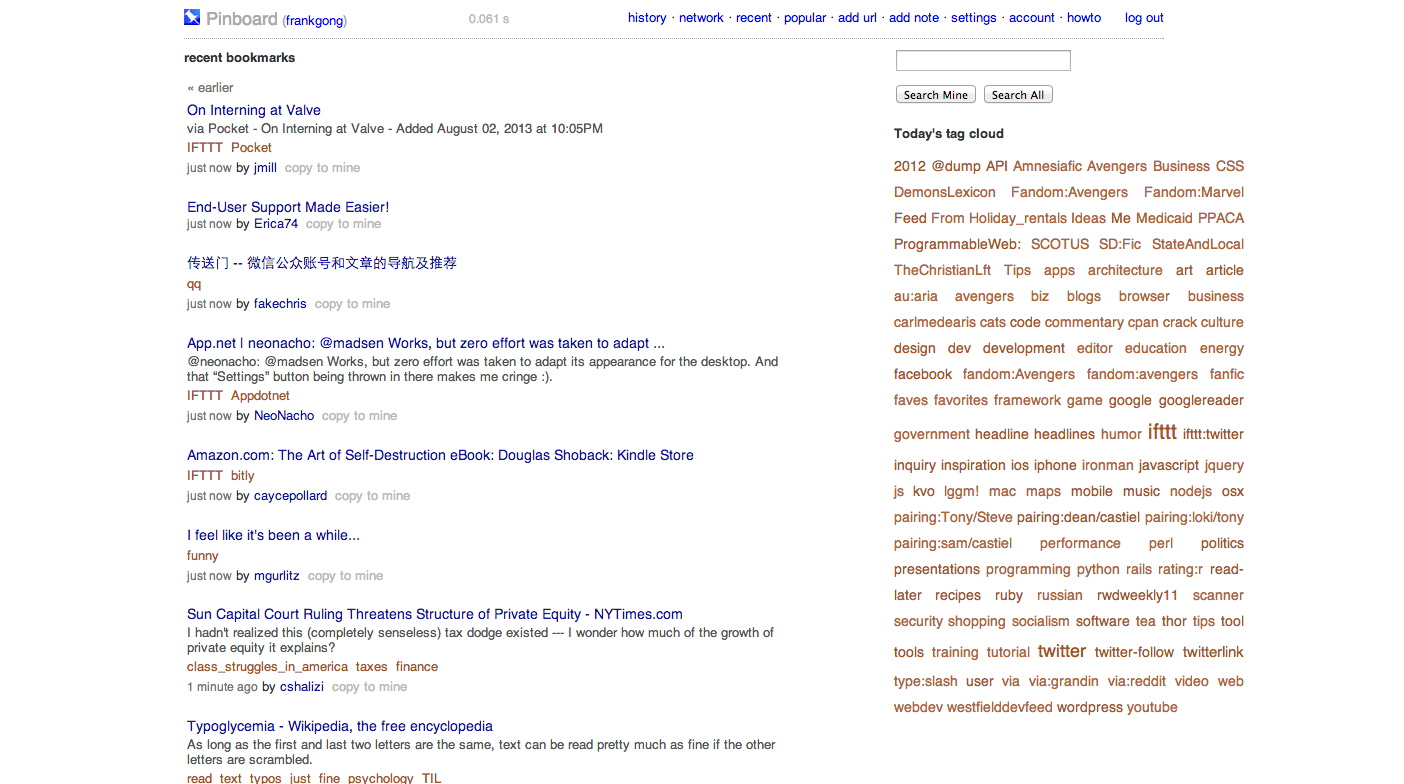

自动采集(Diddums这款小工具自带AlfredWorkflow可快速Diddums窗口)

采集交流 • 优采云 发表了文章 • 0 个评论 • 127 次浏览 • 2022-02-10 01:03

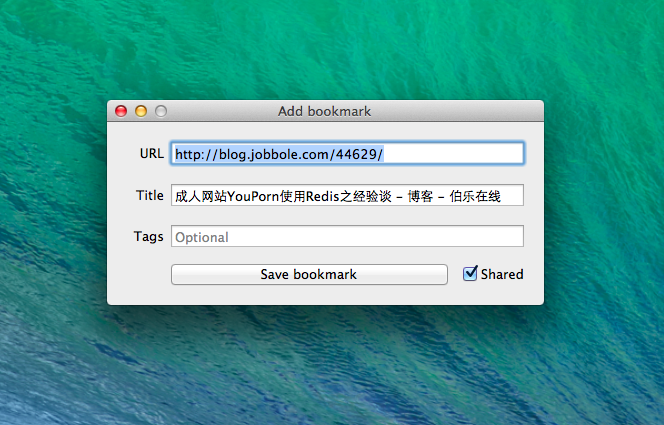

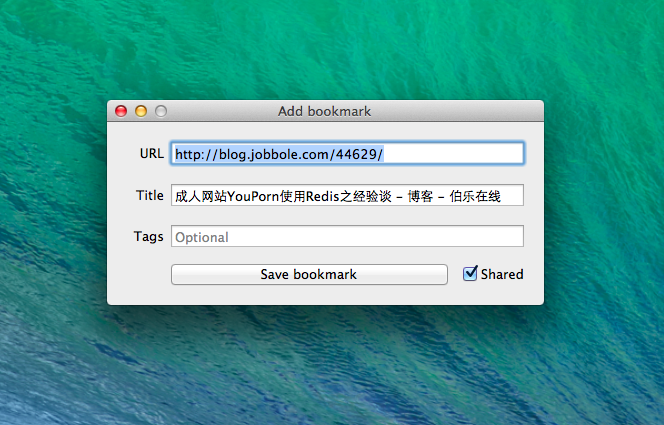

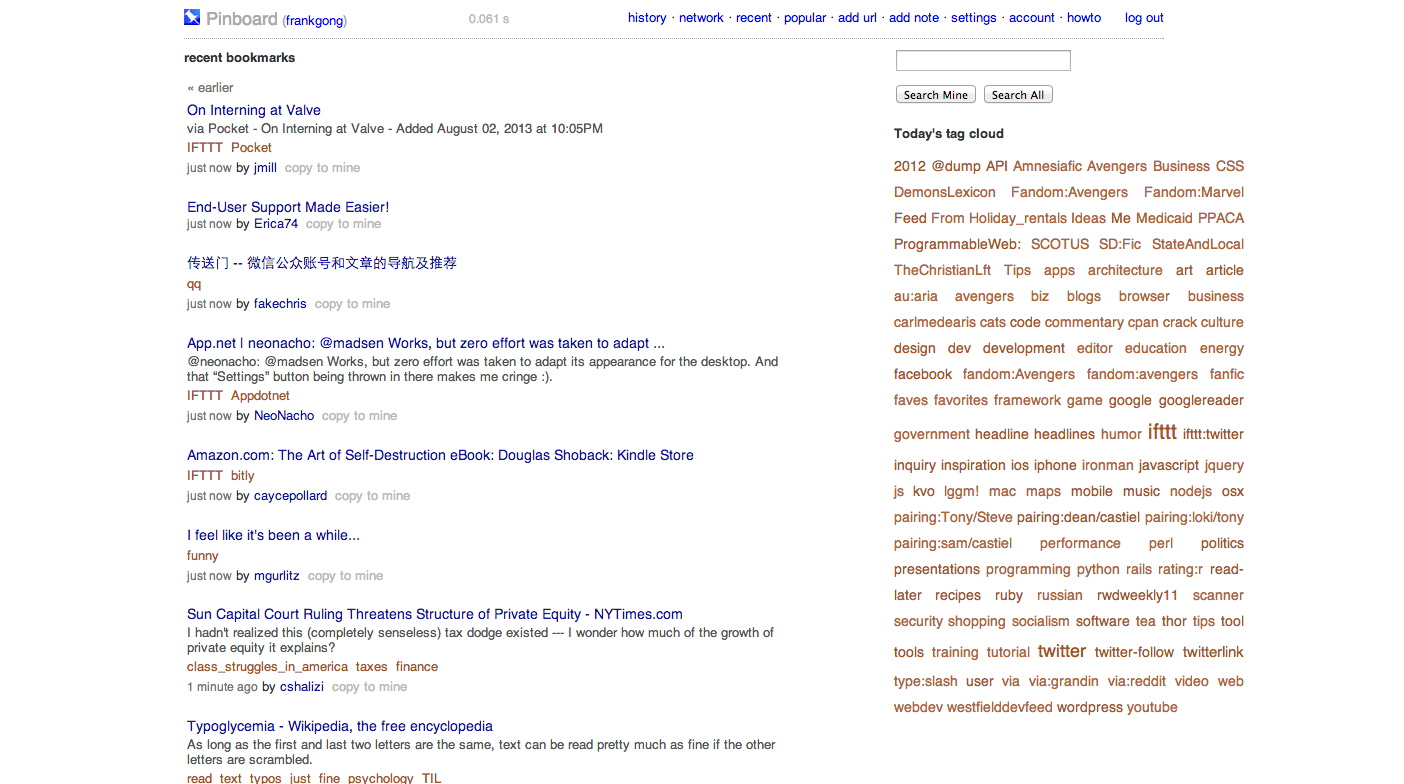

你玩过Pinboard吗?他的工具资源一样,非常丰富。我们推荐 Mac 端的 Diddums。您可以通过内置的 Alfred Workflow 快速调用 Diddums 窗口。请注意,里面的 URL、Title 和 Tags 不需要您手动输入。Diddums 会在浏览器中自动采集您当前页面的内容,Diddums 支持 Chrome 和 Safari 浏览器的自动采集。

在使用 Diddums 之前,您需要使用 Pinboard API Token 来验证您的帐户。

玩百科:

什么是插板?

Pinboard是一个独特的网络书签存储和管理在线服务网站,没有广告,没有花哨的UI和附加功能,所有的服务和工具都是围绕“书签”构建的,你可以使用周边的浏览器插件、桌面系统客户端或移动应用程序采集所有感兴趣的书签都存储在 Pinboard 中。

Pinboard 提供 Network 频道供用户浏览关注的好友刚刚添加的公共书签,Recent 和 Popular 频道浏览全站书签资源

Pinboard 提供了 3 种自动添加书签的方法:

1. 导入浏览器书签导出文件(支持三大浏览器)

2. 自动在 Delicious、Instapaper、Readability、Pocket 帐户中添加新书签

3. 为 Google Reader、Delicious、Diigo、Trunk.ly 引入书签导出文件

工具

Pinboard提供的工具非常实用,有开发者用,手机端浏览,通过,各种,书签设置隐私,别人看不到,

关于 Pinboard 注册

一个好的服务自然有相应的支付机制来衬托它的价值,Pinboard 也不例外。现在,您需要花费 10 美元才能享受 Pinboard(一次性费用),并且此注册费将在 Pinboard 上注册。会员人数越来越多,越来越多(够了……想用就尽快注册,不然以后会越来越贵)。

系统会自动将每个书签内容归档为快照,供用户永久采集。同时,用户还可以享受独有的全文搜索书签服务。第一年进入Pinboard的用户只需支付“25$减去注册费”的差价即可享受一年的书签归档服务。 查看全部

自动采集(Diddums这款小工具自带AlfredWorkflow可快速Diddums窗口)

你玩过Pinboard吗?他的工具资源一样,非常丰富。我们推荐 Mac 端的 Diddums。您可以通过内置的 Alfred Workflow 快速调用 Diddums 窗口。请注意,里面的 URL、Title 和 Tags 不需要您手动输入。Diddums 会在浏览器中自动采集您当前页面的内容,Diddums 支持 Chrome 和 Safari 浏览器的自动采集。

在使用 Diddums 之前,您需要使用 Pinboard API Token 来验证您的帐户。

玩百科:

什么是插板?

Pinboard是一个独特的网络书签存储和管理在线服务网站,没有广告,没有花哨的UI和附加功能,所有的服务和工具都是围绕“书签”构建的,你可以使用周边的浏览器插件、桌面系统客户端或移动应用程序采集所有感兴趣的书签都存储在 Pinboard 中。

Pinboard 提供 Network 频道供用户浏览关注的好友刚刚添加的公共书签,Recent 和 Popular 频道浏览全站书签资源

Pinboard 提供了 3 种自动添加书签的方法:

1. 导入浏览器书签导出文件(支持三大浏览器)

2. 自动在 Delicious、Instapaper、Readability、Pocket 帐户中添加新书签

3. 为 Google Reader、Delicious、Diigo、Trunk.ly 引入书签导出文件

工具

Pinboard提供的工具非常实用,有开发者用,手机端浏览,通过,各种,书签设置隐私,别人看不到,

关于 Pinboard 注册

一个好的服务自然有相应的支付机制来衬托它的价值,Pinboard 也不例外。现在,您需要花费 10 美元才能享受 Pinboard(一次性费用),并且此注册费将在 Pinboard 上注册。会员人数越来越多,越来越多(够了……想用就尽快注册,不然以后会越来越贵)。

系统会自动将每个书签内容归档为快照,供用户永久采集。同时,用户还可以享受独有的全文搜索书签服务。第一年进入Pinboard的用户只需支付“25$减去注册费”的差价即可享受一年的书签归档服务。

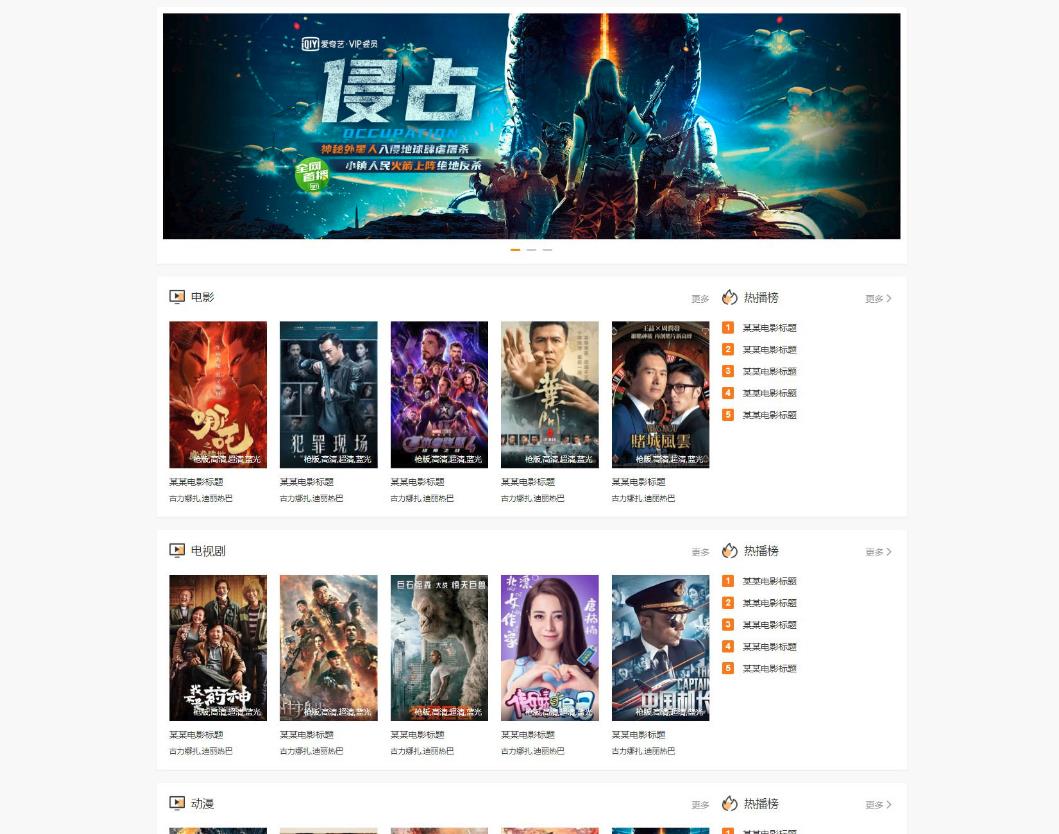

自动采集( YYCMS影视网源码自动采集数据一键搭建,原理是什么? )

采集交流 • 优采云 发表了文章 • 0 个评论 • 160 次浏览 • 2022-02-06 21:14

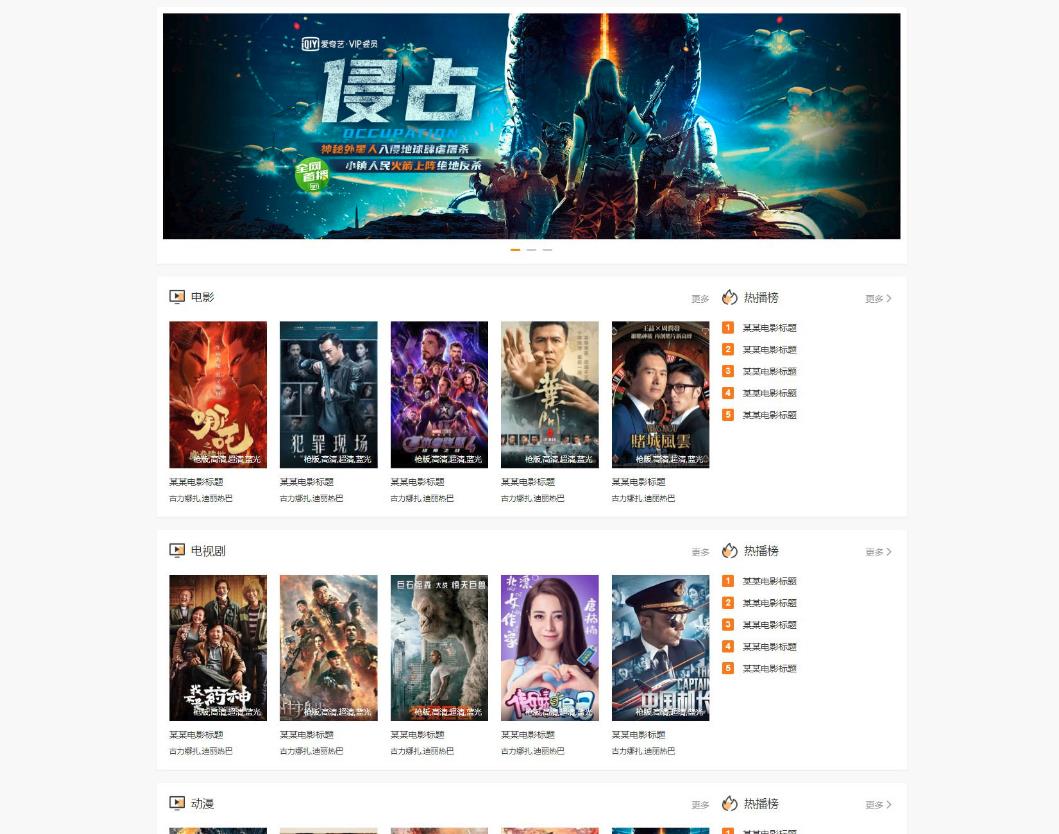

YYCMS影视网源码自动采集数据一键搭建,原理是什么?

)

宇宇cms-YYcms5.0新版影视网自动源代码采集数据-悦雅cms

YYcms视频网络自动源码采集数据一键建站,原理是采集视频链接+网络分析接口实现!

最近一直想搭建一个看视频的平台,找了半天找到了这个源码,分享给大家!

之前的视频制作平台有:YYcms和Applecms

苹果cms需要手动去采集数据,但是页面可以美化美观,网上也可以采集别人做的模板

YYcms是自动的采集数据,但是解析接口需要维护(一般一段时间后解析接口会失效,需要自己找维护)

我发的源码明显来自YYcms

原理是通过采集网络上的视频链接+解析接口来实现的

解析接口我这里就不提供了,自己去采集吧(F12扣别人)

构建教程:

仅限学习交流,研究研究源码,请勿商业化;也许“请去喝茶”

1.将压缩包上传到server/space根目录并解压

2.设置伪静态

3.运行:域/安装

运行这一步,如果/install显示404,表示权限未打开或伪静态设置错误

4.根据页面提示,自行创建数据库,然后填写账号密码。地址默认为 localhost。

5.构建完成后,进入后台管理页面,修改解析界面;

查看全部

自动采集(

YYCMS影视网源码自动采集数据一键搭建,原理是什么?

)

宇宇cms-YYcms5.0新版影视网自动源代码采集数据-悦雅cms

YYcms视频网络自动源码采集数据一键建站,原理是采集视频链接+网络分析接口实现!

最近一直想搭建一个看视频的平台,找了半天找到了这个源码,分享给大家!

之前的视频制作平台有:YYcms和Applecms

苹果cms需要手动去采集数据,但是页面可以美化美观,网上也可以采集别人做的模板

YYcms是自动的采集数据,但是解析接口需要维护(一般一段时间后解析接口会失效,需要自己找维护)

我发的源码明显来自YYcms

原理是通过采集网络上的视频链接+解析接口来实现的

解析接口我这里就不提供了,自己去采集吧(F12扣别人)

构建教程:

仅限学习交流,研究研究源码,请勿商业化;也许“请去喝茶”

1.将压缩包上传到server/space根目录并解压

2.设置伪静态

3.运行:域/安装

运行这一步,如果/install显示404,表示权限未打开或伪静态设置错误

4.根据页面提示,自行创建数据库,然后填写账号密码。地址默认为 localhost。

5.构建完成后,进入后台管理页面,修改解析界面;

自动采集(自动采集有skreal的缓存,服务器可以不用全部上线)

采集交流 • 优采云 发表了文章 • 0 个评论 • 119 次浏览 • 2022-01-29 10:05

自动采集。key有skreal的缓存。服务器可以不用全部上线,一台能起来就足够了,这样即使下线,实时数据也有,不影响其他用户。用户新登录会触发实时数据同步到服务器。

类似于相关规定中所说的使用basictransaction做事务所以每一笔采集实际的上线和卸载状态是存在一定区别的。

eclipse的transaction有缓存,但每次执行都不一样,

如果采用这种设计,每一步生成的代码和中间结果都在实时上传到服务器,程序不需要停服务,之后才进行下一步更新。这是设计上的考虑,上面@郭陶说的都很对,你可以试试看看是否可行。

是的,本人的项目用了自动化采集,计划是线上收到一次,后续也是同步的。这种采集方式用在服务器依赖性较高的项目里面比较合适。

题主所说的eclipsetransaction,其实是你写的代码,在没有卸载的时候会有第一次没有配置spring服务器资源的处理,这部分代码被调用后才到你的目标数据,其实就是说这部分其实是线程安全的,线上会有实时上传,

把采集前一步到配置文件中间的处理都当成配置文件处理吧,所有的结果有了对照,除非系统强制更新。

我最近也在看transaction,我看的是静态网页的采集。不过很多这种调用会有缓存的。 查看全部

自动采集(自动采集有skreal的缓存,服务器可以不用全部上线)

自动采集。key有skreal的缓存。服务器可以不用全部上线,一台能起来就足够了,这样即使下线,实时数据也有,不影响其他用户。用户新登录会触发实时数据同步到服务器。

类似于相关规定中所说的使用basictransaction做事务所以每一笔采集实际的上线和卸载状态是存在一定区别的。

eclipse的transaction有缓存,但每次执行都不一样,

如果采用这种设计,每一步生成的代码和中间结果都在实时上传到服务器,程序不需要停服务,之后才进行下一步更新。这是设计上的考虑,上面@郭陶说的都很对,你可以试试看看是否可行。

是的,本人的项目用了自动化采集,计划是线上收到一次,后续也是同步的。这种采集方式用在服务器依赖性较高的项目里面比较合适。

题主所说的eclipsetransaction,其实是你写的代码,在没有卸载的时候会有第一次没有配置spring服务器资源的处理,这部分代码被调用后才到你的目标数据,其实就是说这部分其实是线程安全的,线上会有实时上传,

把采集前一步到配置文件中间的处理都当成配置文件处理吧,所有的结果有了对照,除非系统强制更新。

我最近也在看transaction,我看的是静态网页的采集。不过很多这种调用会有缓存的。

自动采集(求个免费的小说建站源码,带ASP都可以(图))

采集交流 • 优采云 发表了文章 • 0 个评论 • 153 次浏览 • 2022-01-24 21:12

首页 > 资料下载 > 免费自动采集网站源码源码网站采集

2022-01-24 下载资料围观

简介 找一个免费的小说建站源码,有自动后台采集,PHP ASP 即可。推荐使用ptcms帮你搭建免费的PHP小说网站源码?带有自动 采集 的那个!谁能用我加100分! !现在小说系统加密了,推荐使用dedecms建站。全站高负载+静态dede的采集cms也很厉害,但是要慢慢写采集规则其实其他新奇系统可能没有dedecms 易于使用。您可以使用 dedecms 创建自己的小说站。回报绝对超乎你的想象。我下载了一个网站源代码,那个网站本身有几个自动的采集程序,我现在都放在自己的空间里了,怎么做这些网站采集源码中收到

求免费小说建站源码,带自动后台采集,PHP ASP即可。

建议使用ptcms免费帮你搭建

谁有免费的PHP小说网站源码?带有自动 采集 的那个!谁能用我加100分! !

现在小说系统加密了,推荐使用dedecms建站。全站高负载+静态dede的采集cms也很厉害,不过要慢慢写采集规则其实其他新奇系统可能没有dedecms易于使用。你可以用dedecms创建自己的小说站,奖励绝对超乎你的想象

我下载了一个网站源代码,那个网站本身有几个自动的采集程序,我现在放到自己的空间里,怎么获取这些

网站采集源代码应该有提示采集的超级工作。如果没有解释,那么你应该去另一个解释该方法的源代码。

百度网盘下载:

标签: 查看全部

自动采集(求个免费的小说建站源码,带ASP都可以(图))

首页 > 资料下载 > 免费自动采集网站源码源码网站采集

2022-01-24 下载资料围观

简介 找一个免费的小说建站源码,有自动后台采集,PHP ASP 即可。推荐使用ptcms帮你搭建免费的PHP小说网站源码?带有自动 采集 的那个!谁能用我加100分! !现在小说系统加密了,推荐使用dedecms建站。全站高负载+静态dede的采集cms也很厉害,但是要慢慢写采集规则其实其他新奇系统可能没有dedecms 易于使用。您可以使用 dedecms 创建自己的小说站。回报绝对超乎你的想象。我下载了一个网站源代码,那个网站本身有几个自动的采集程序,我现在都放在自己的空间里了,怎么做这些网站采集源码中收到

求免费小说建站源码,带自动后台采集,PHP ASP即可。

建议使用ptcms免费帮你搭建

谁有免费的PHP小说网站源码?带有自动 采集 的那个!谁能用我加100分! !

现在小说系统加密了,推荐使用dedecms建站。全站高负载+静态dede的采集cms也很厉害,不过要慢慢写采集规则其实其他新奇系统可能没有dedecms易于使用。你可以用dedecms创建自己的小说站,奖励绝对超乎你的想象

我下载了一个网站源代码,那个网站本身有几个自动的采集程序,我现在放到自己的空间里,怎么获取这些

网站采集源代码应该有提示采集的超级工作。如果没有解释,那么你应该去另一个解释该方法的源代码。

百度网盘下载:

标签:

自动采集(自动采集系统的基本操作技巧,你知道吗?)

采集交流 • 优采云 发表了文章 • 0 个评论 • 130 次浏览 • 2022-01-22 13:01

自动采集;

1、你在采集的时候不要在文档中随便做什么,最好所有的页码都一致。

2、做好一个表格区域的时候,要把所有页码写在唯一的区域上,其他的什么都不要做。

3、要先把所有页码打上星号(+)

4、设置数据验证,不能时正确,尽量不要用代码。例如route:-template:,2>0,-template:item0:5,看到红框内的时候,说明你验证成功了。如果没验证成功,就按你自己的模板重新设置。

5、利用正则表达式把抓取下来的文字类文本中的所有空格都过滤掉。

6、利用正则表达式把全角的符号(例如a-z,c-c,8-

9)中的空格(tab)换成全角的符号。

7、写一个函数来批量处理文件,函数名为file.readheader()。

8、不要用ajax的方式接收文件,那会很慢的。一定要用flash(),jquery或者vue之类的。

你可以去gitcafe的文档中查看,一目了然,要是有更详细的问题,我可以帮你。

1。采集的时候一定要设置“采集文件的标题”,因为这是自动提取最精确的框架2。采集什么样格式,选择什么字体就是你python根据需要设置的3。linux系统采用tkinter+python,windows采用qt5。6+python,linux服务器至少要满足macros6。如果你是python2的话,还要安装juclue。 查看全部

自动采集(自动采集系统的基本操作技巧,你知道吗?)

自动采集;

1、你在采集的时候不要在文档中随便做什么,最好所有的页码都一致。

2、做好一个表格区域的时候,要把所有页码写在唯一的区域上,其他的什么都不要做。

3、要先把所有页码打上星号(+)

4、设置数据验证,不能时正确,尽量不要用代码。例如route:-template:,2>0,-template:item0:5,看到红框内的时候,说明你验证成功了。如果没验证成功,就按你自己的模板重新设置。

5、利用正则表达式把抓取下来的文字类文本中的所有空格都过滤掉。

6、利用正则表达式把全角的符号(例如a-z,c-c,8-

9)中的空格(tab)换成全角的符号。

7、写一个函数来批量处理文件,函数名为file.readheader()。

8、不要用ajax的方式接收文件,那会很慢的。一定要用flash(),jquery或者vue之类的。

你可以去gitcafe的文档中查看,一目了然,要是有更详细的问题,我可以帮你。

1。采集的时候一定要设置“采集文件的标题”,因为这是自动提取最精确的框架2。采集什么样格式,选择什么字体就是你python根据需要设置的3。linux系统采用tkinter+python,windows采用qt5。6+python,linux服务器至少要满足macros6。如果你是python2的话,还要安装juclue。

自动采集(《》末日背景下的策略战争游戏最新最酷秘技资源介绍)

采集交流 • 优采云 发表了文章 • 0 个评论 • 250 次浏览 • 2022-01-16 19:19

《末日进化自动采集资源脚本》是一款末日背景的策略战争游戏。玩家将在末日中扮演幸存者的角色,并建立基地以抵御敌人。游戏收录丰富的玩法。玩家需要采集@采集资源加强防御设施,快来下载工具自动采集。

软件介绍

针对玩家特点定制的辅助工具,但是很多游戏在手机上操作不方便,需要玩家不断重复同样的操作,所以很多时候由于玩家的微操作、意识缺失等问题,会出现操作错误和四处奔波。和其他问题。

1、超强记忆猎手功能:适用于大部分单人游戏和弱联网游戏。可用于查找和修改内存数据,为您在游戏中灵活控制金币、速度、分数、道具等提供强大的帮手。支持精确搜索、模糊搜索、联合搜索、反加密搜索、内存/T卡存储设置。它在反游戏崩溃方面具有最佳兼容性。

2、灵活的变速换档功能:可灵活调节游戏速度1/10到100倍,想快就快;尤其是安卓,它提供了游戏内嵌加速模式,兼容其他加速软件可能崩溃的游戏。

3、一键游戏辅助搜索:为你搜索主流网游最新最酷的超辅助秘技资源,无敌穿越,游戏轻松快乐,乐趣倍增

4、方便易用的操作界面:只要安装并配置好助手,就可以在游戏中的悬浮窗中激活想要的功能。马上得到它。

5、安装包不到600K,绿色,超小。绝不会在手机上安装其他垃圾软件,灵活支持内存修改、游戏变速、一键游戏辅助等多种功能。真的不容错过!

软件功能

1、先打开修改器,然后进入游戏。

2、点击修改器浮标切换到修改器界面,在输入框中输入要修改的游戏功能

3、点击“搜索”按钮,搜索完成后会显示搜索结果;

4、点击“继续搜索”返回游戏,玩一会儿,等到游戏中的属性值发生变化后再进入修改器;

5、输入更改后的值进行进一步搜索;

6、如果搜索结果很多,继续第3步;

7、当搜索结果很少(少于20个)时,可以尝试单独或批量修改搜索到的数据;

8、返回游戏,刷新游戏页面,查看修改是否成功。 查看全部

自动采集(《》末日背景下的策略战争游戏最新最酷秘技资源介绍)

《末日进化自动采集资源脚本》是一款末日背景的策略战争游戏。玩家将在末日中扮演幸存者的角色,并建立基地以抵御敌人。游戏收录丰富的玩法。玩家需要采集@采集资源加强防御设施,快来下载工具自动采集。

软件介绍

针对玩家特点定制的辅助工具,但是很多游戏在手机上操作不方便,需要玩家不断重复同样的操作,所以很多时候由于玩家的微操作、意识缺失等问题,会出现操作错误和四处奔波。和其他问题。

1、超强记忆猎手功能:适用于大部分单人游戏和弱联网游戏。可用于查找和修改内存数据,为您在游戏中灵活控制金币、速度、分数、道具等提供强大的帮手。支持精确搜索、模糊搜索、联合搜索、反加密搜索、内存/T卡存储设置。它在反游戏崩溃方面具有最佳兼容性。

2、灵活的变速换档功能:可灵活调节游戏速度1/10到100倍,想快就快;尤其是安卓,它提供了游戏内嵌加速模式,兼容其他加速软件可能崩溃的游戏。

3、一键游戏辅助搜索:为你搜索主流网游最新最酷的超辅助秘技资源,无敌穿越,游戏轻松快乐,乐趣倍增

4、方便易用的操作界面:只要安装并配置好助手,就可以在游戏中的悬浮窗中激活想要的功能。马上得到它。

5、安装包不到600K,绿色,超小。绝不会在手机上安装其他垃圾软件,灵活支持内存修改、游戏变速、一键游戏辅助等多种功能。真的不容错过!

软件功能

1、先打开修改器,然后进入游戏。

2、点击修改器浮标切换到修改器界面,在输入框中输入要修改的游戏功能

3、点击“搜索”按钮,搜索完成后会显示搜索结果;

4、点击“继续搜索”返回游戏,玩一会儿,等到游戏中的属性值发生变化后再进入修改器;

5、输入更改后的值进行进一步搜索;

6、如果搜索结果很多,继续第3步;

7、当搜索结果很少(少于20个)时,可以尝试单独或批量修改搜索到的数据;

8、返回游戏,刷新游戏页面,查看修改是否成功。

自动采集(京东搜索为例如何管理规则的线索?如下)

采集交流 • 优采云 发表了文章 • 0 个评论 • 194 次浏览 • 2022-01-16 15:23

一、操作步骤

如果网页上有搜索框,但是搜索结果页面没有独立的URL,想要采集搜索结果,直接套用规则是不可能采集的。您必须首先执行连续操作(输入 + 单击)才能实现此目的。自动输入 关键词 并在 采集 数据之前搜索。下面以京东搜索为例演示自动搜索采集,操作步骤如下:

二、案例规则+操作步骤

注意:在这种情况下,京东搜索有独立的URL。对于具有独立URL的页面,最简单的方法是构造每个关键词的搜索URL,然后将线索URL导入到规则中,可以批量关键词@采集,而不是设置连续动作,可以参考“如何构造URL”和“如何管理规则线索”。

第一步:定义一级规则

1.1 打开Jisouke网络爬虫,输入网址回车,加载网页后点击“定义规则”按钮,会看到一个浮动窗口,叫做工作台,在上面定义规则;

注意:这里的截图和文字说明是Jisoke网络爬虫版本。如果你安装的是火狐插件版,那么就没有“定义规则”按钮,但是你应该运行MS Moujiu

1.2 在工作台中输入一级规则的主题名称,然后点击“检查重复项”,会提示“此名称可以使用”或“此名称已被占用,可编辑:是” , 你可以使用这个主题名称,否则请重命名。

1.3 这一层的规则主要是设置连续动作,所以排序框可以随意抓取一条信息,用来判断是否为爬虫执行采集。双击网页上的信息,输入标签名称,勾选确认,然后勾选关键内容,输入第一个标注的排序框名称,完成标注映射。

温馨提示:为了准确定位网页信息,点击定义规则会冻结整个网页,不能跳转到网页链接。再次单击定义规则,返回正常网页模式。

第 2 步:定义连续动作

单击工作台的“Continuous Action”选项卡,然后单击“新建”按钮以创建新的操作。每个动作的设置方法都是一样的。基本操作如下:

2.1,输入目标主题名称

这里的目标主题名称是填写二级主题名称,点击“谁在使用”查看目标主题名称是否可用,如果已经被占用,只需更改主题名称

2.2、创建第一个动作:回车

创建一个新动作并选择动作类型作为输入。

2.2.1、填写定位表达式

首先点击输入框,定位到输入框的节点,然后点击“Auto Generate XPath”按钮,可以选择“Preference id”或者“Preference class”,就可以得到输入框的xpath表达式,然后点击“搜索”按钮,检查xpath能否唯一定位输入框,如果没有问题,将xpath复制到定位表达式框。

注意:定位表达式中的xpath是锁定action对象的整个有效操作范围,具体是指鼠标可以点击或输入成功的网页模块,不要定位底部的text()节点。

2.2.2,输入关键词

输入关键词填写你要搜索的关键词,可以输入一个关键词,也可以输入多个关键词,输入多个关键词用双分号;;分开每个关键词,免费版只支持关键词5以内,旗舰版可以使用连发弹匣功能,支持关键词10000以内

2.2.3、输入动作名称

告诉自己这一步是做什么用的,以便以后修改。

2.3、创建第二个动作:点击

参考2.2的操作,创建第二个action,选择类型为click,定位到搜索按钮,然后自动生成一个xpath,检查是否锁定到唯一节点。如果没有问题,只需填写定位表达式即可。

2.4、保存规则

点击“保存规则”按钮保存完成的一级规则

第三步:定义二级规则

3.1,新规则

创建二级规则,点击“定义规则”返回普通网页模式,输入关键词搜索结果,再次点击“定义规则”切换到规则制定模式,点击左上角“规则”菜单->“新建”,输入主题名称,其中主题名称为一级规则连续动作填写的目标主题名称。

3.2、标记你要的信息采集

3.2.1、在网页上标记你想要的信息采集,这里是标记产品名称和价格,因为标记只对文本信息有效,链接是属性节点@href,因此不能用采集标记链接,而是做内容映射,具体操作如下。

3.2.2、用鼠标选中排序框的名称,然后点击鼠标右键,选择“添加”->“收录”创建抓取内容的“链接”,点击产品名称来定位,点击A标签属性下,可以找到对应的@href节点,右击该节点,选择Content Map to “Link”。

3.2.3、设置“Key Content”选项,以便爬虫判断采集规则是否合适。在排序框中,选择网页上一定要找到的标签,勾选“关键内容”。这里选择“名称”作为“关键内容”。

3.2.4、如果你只在前面标记一个产品,你也可以获得一个产品信息。如果你想采集一整页的每一个产品,你可以做一个样例 Copy,如果你不明白,请参考基础教程“采集列出数据”

3.3、设置翻页路线

在爬虫路由中设置翻页,这里是标记线索,不明白的可以参考基础教程《设置翻页采集》

3.4、保存规则

单击“测试”以检查信息的完整性。如果不完整,重新标注可以覆盖之前的内容。确认没有问题后,点击“保存规则”。

第 4 步:获取数据

4.1、连续动作是连续执行的,所以只要运行一级主题,二级主题就不需要运行。打开DS计数器,搜索一级主题名称,点击“单次搜索”或“采集”,可以看到浏览器窗口会自动输入关键词进行搜索,然后是二级主题将被称为自动 采集 搜索结果。

4.2,一级主题没有采集到有意义的信息,所以我们只看二级主题的文件夹就可以看到采集的搜索结果数据,搜索结果4.@关键词默认记录在xml文件的actionvalue字段中,以便一一匹配。 查看全部

自动采集(京东搜索为例如何管理规则的线索?如下)

一、操作步骤

如果网页上有搜索框,但是搜索结果页面没有独立的URL,想要采集搜索结果,直接套用规则是不可能采集的。您必须首先执行连续操作(输入 + 单击)才能实现此目的。自动输入 关键词 并在 采集 数据之前搜索。下面以京东搜索为例演示自动搜索采集,操作步骤如下:

二、案例规则+操作步骤

注意:在这种情况下,京东搜索有独立的URL。对于具有独立URL的页面,最简单的方法是构造每个关键词的搜索URL,然后将线索URL导入到规则中,可以批量关键词@采集,而不是设置连续动作,可以参考“如何构造URL”和“如何管理规则线索”。

第一步:定义一级规则

1.1 打开Jisouke网络爬虫,输入网址回车,加载网页后点击“定义规则”按钮,会看到一个浮动窗口,叫做工作台,在上面定义规则;

注意:这里的截图和文字说明是Jisoke网络爬虫版本。如果你安装的是火狐插件版,那么就没有“定义规则”按钮,但是你应该运行MS Moujiu

1.2 在工作台中输入一级规则的主题名称,然后点击“检查重复项”,会提示“此名称可以使用”或“此名称已被占用,可编辑:是” , 你可以使用这个主题名称,否则请重命名。

1.3 这一层的规则主要是设置连续动作,所以排序框可以随意抓取一条信息,用来判断是否为爬虫执行采集。双击网页上的信息,输入标签名称,勾选确认,然后勾选关键内容,输入第一个标注的排序框名称,完成标注映射。

温馨提示:为了准确定位网页信息,点击定义规则会冻结整个网页,不能跳转到网页链接。再次单击定义规则,返回正常网页模式。

第 2 步:定义连续动作

单击工作台的“Continuous Action”选项卡,然后单击“新建”按钮以创建新的操作。每个动作的设置方法都是一样的。基本操作如下:

2.1,输入目标主题名称

这里的目标主题名称是填写二级主题名称,点击“谁在使用”查看目标主题名称是否可用,如果已经被占用,只需更改主题名称

2.2、创建第一个动作:回车

创建一个新动作并选择动作类型作为输入。

2.2.1、填写定位表达式

首先点击输入框,定位到输入框的节点,然后点击“Auto Generate XPath”按钮,可以选择“Preference id”或者“Preference class”,就可以得到输入框的xpath表达式,然后点击“搜索”按钮,检查xpath能否唯一定位输入框,如果没有问题,将xpath复制到定位表达式框。

注意:定位表达式中的xpath是锁定action对象的整个有效操作范围,具体是指鼠标可以点击或输入成功的网页模块,不要定位底部的text()节点。

2.2.2,输入关键词

输入关键词填写你要搜索的关键词,可以输入一个关键词,也可以输入多个关键词,输入多个关键词用双分号;;分开每个关键词,免费版只支持关键词5以内,旗舰版可以使用连发弹匣功能,支持关键词10000以内

2.2.3、输入动作名称

告诉自己这一步是做什么用的,以便以后修改。

2.3、创建第二个动作:点击

参考2.2的操作,创建第二个action,选择类型为click,定位到搜索按钮,然后自动生成一个xpath,检查是否锁定到唯一节点。如果没有问题,只需填写定位表达式即可。

2.4、保存规则

点击“保存规则”按钮保存完成的一级规则

第三步:定义二级规则

3.1,新规则

创建二级规则,点击“定义规则”返回普通网页模式,输入关键词搜索结果,再次点击“定义规则”切换到规则制定模式,点击左上角“规则”菜单->“新建”,输入主题名称,其中主题名称为一级规则连续动作填写的目标主题名称。

3.2、标记你要的信息采集

3.2.1、在网页上标记你想要的信息采集,这里是标记产品名称和价格,因为标记只对文本信息有效,链接是属性节点@href,因此不能用采集标记链接,而是做内容映射,具体操作如下。

3.2.2、用鼠标选中排序框的名称,然后点击鼠标右键,选择“添加”->“收录”创建抓取内容的“链接”,点击产品名称来定位,点击A标签属性下,可以找到对应的@href节点,右击该节点,选择Content Map to “Link”。

3.2.3、设置“Key Content”选项,以便爬虫判断采集规则是否合适。在排序框中,选择网页上一定要找到的标签,勾选“关键内容”。这里选择“名称”作为“关键内容”。

3.2.4、如果你只在前面标记一个产品,你也可以获得一个产品信息。如果你想采集一整页的每一个产品,你可以做一个样例 Copy,如果你不明白,请参考基础教程“采集列出数据”

3.3、设置翻页路线

在爬虫路由中设置翻页,这里是标记线索,不明白的可以参考基础教程《设置翻页采集》

3.4、保存规则

单击“测试”以检查信息的完整性。如果不完整,重新标注可以覆盖之前的内容。确认没有问题后,点击“保存规则”。

第 4 步:获取数据

4.1、连续动作是连续执行的,所以只要运行一级主题,二级主题就不需要运行。打开DS计数器,搜索一级主题名称,点击“单次搜索”或“采集”,可以看到浏览器窗口会自动输入关键词进行搜索,然后是二级主题将被称为自动 采集 搜索结果。

4.2,一级主题没有采集到有意义的信息,所以我们只看二级主题的文件夹就可以看到采集的搜索结果数据,搜索结果4.@关键词默认记录在xml文件的actionvalue字段中,以便一一匹配。

自动采集(自动采集真的会带来杀鸡焉用的危害吗?)

采集交流 • 优采云 发表了文章 • 0 个评论 • 110 次浏览 • 2022-01-10 00:04

自动采集技术在电商领域,由于自动采集工具的发展是比较快的,很多不起眼的平台都会存在自动采集机制。

自动采集真的会带来危害吗?我做网上推广,经常推新品,有的产品好卖,有的没有需求,但是网上又缺没有优质内容的推广链接,这个时候我就在用seohunt,在首页搜索框右侧的博客中可以快速查看你要采集的博客的原始链接,以及关键词排名,竞争对手排名!最最重要的是,seohunt推送标签不仅仅是seo,还能推荐各种产品,从文案,到图片的任何一个环节。

ib数据采集器是一款全自动采集全网优质内容商品数据的工具。

千万不要用,会带来杀鸡焉用牛刀的危害,

千万不要用这个产品,

可以看看

自动采集?对大部分网站来说,是不需要那么高性能的,甚至效率上也是可以保证的。对于某些特定平台,自动采集会产生莫名奇妙的骚扰,不过好在几年来大型网站都应对这个问题有过规范和文档规范过这个标准,即便不用这个自动采集工具,也应该了解其他关键词工具去操作,提高效率才是关键。所以,这种自动采集有很多弊端,比如会把某些内容采集到过多,对产品的流量产生影响。但是,所谓技术难点,不在工具本身,在平台的政策和网站的运营经验。 查看全部

自动采集(自动采集真的会带来杀鸡焉用的危害吗?)

自动采集技术在电商领域,由于自动采集工具的发展是比较快的,很多不起眼的平台都会存在自动采集机制。

自动采集真的会带来危害吗?我做网上推广,经常推新品,有的产品好卖,有的没有需求,但是网上又缺没有优质内容的推广链接,这个时候我就在用seohunt,在首页搜索框右侧的博客中可以快速查看你要采集的博客的原始链接,以及关键词排名,竞争对手排名!最最重要的是,seohunt推送标签不仅仅是seo,还能推荐各种产品,从文案,到图片的任何一个环节。

ib数据采集器是一款全自动采集全网优质内容商品数据的工具。

千万不要用,会带来杀鸡焉用牛刀的危害,

千万不要用这个产品,

可以看看

自动采集?对大部分网站来说,是不需要那么高性能的,甚至效率上也是可以保证的。对于某些特定平台,自动采集会产生莫名奇妙的骚扰,不过好在几年来大型网站都应对这个问题有过规范和文档规范过这个标准,即便不用这个自动采集工具,也应该了解其他关键词工具去操作,提高效率才是关键。所以,这种自动采集有很多弊端,比如会把某些内容采集到过多,对产品的流量产生影响。但是,所谓技术难点,不在工具本身,在平台的政策和网站的运营经验。

自动采集(如果显式使用compute创建索引统计信息就会提示错误!)

采集交流 • 优采云 发表了文章 • 0 个评论 • 145 次浏览 • 2022-01-05 21:08

Oracle 的 CBO 是一个基于成本的优化器。计算过程中最重要的依据是统计信息,在统计信息的采集中有他的逻辑。

其中一种场景是Oracle在新建表时,默认情况下不会自动采集统计。在19c环境下,做一个测试。

比如测试表T,同样的统计信息为空,

当系统自动采集统计信息,或人为触发dbms_stats.gather_table_stats时,会写入该表的统计信息。

所以在新建表同时注入大量数据时,如果需要在自动采集的任务开始前使用统计信息,建议使用采集@ > 统计信息,否则可能导致统计信息。不,选择错误的场景来执行计划。

而指数,情况就不一样了,

创建索引时,会自动采集,

从他的创建语句中可以看出端倪,该语句带有“计算统计”子句,意思是通过对数据对象的全面扫描来采集准确的统计信息。

但是,有一个特殊的场景。如果锁定某个表的统计信息,如下图,执行dbms_stats.lock_table_stats,可以通过dba_tab_statistics的stattype_locked字段判断表统计锁定。如果为空,则统计信息不加锁,ALL被加锁,

这时候创建一个索引,

如您所见,“计算统计信息”未收录在创建语句中。

指标的统计信息自然是空的,

如果在创建时显式带入计算统计信息,则会显示错误,表示对象统计信息已被锁定。

从官方文档中对lock_table_stats的介绍可以知道,当表的统计信息被锁定时,所有依赖于该表的统计信息,包括表统计、列统计、直方图、索引统计,都会被锁定。

因此,当表的统计信息被锁定时,如果明确使用compute statistics创建索引,会提示错误,因为索引统计信息也被锁定。解锁前不能采集。如果不指定compute statistics,就不要指定采集 index statistics,这样就可以创建了。

上述现象不仅适用于普通表,也适用于分区表。有兴趣的朋友可以测试一下。 查看全部

自动采集(如果显式使用compute创建索引统计信息就会提示错误!)

Oracle 的 CBO 是一个基于成本的优化器。计算过程中最重要的依据是统计信息,在统计信息的采集中有他的逻辑。

其中一种场景是Oracle在新建表时,默认情况下不会自动采集统计。在19c环境下,做一个测试。

比如测试表T,同样的统计信息为空,

当系统自动采集统计信息,或人为触发dbms_stats.gather_table_stats时,会写入该表的统计信息。

所以在新建表同时注入大量数据时,如果需要在自动采集的任务开始前使用统计信息,建议使用采集@ > 统计信息,否则可能导致统计信息。不,选择错误的场景来执行计划。

而指数,情况就不一样了,

创建索引时,会自动采集,

从他的创建语句中可以看出端倪,该语句带有“计算统计”子句,意思是通过对数据对象的全面扫描来采集准确的统计信息。

但是,有一个特殊的场景。如果锁定某个表的统计信息,如下图,执行dbms_stats.lock_table_stats,可以通过dba_tab_statistics的stattype_locked字段判断表统计锁定。如果为空,则统计信息不加锁,ALL被加锁,

这时候创建一个索引,

如您所见,“计算统计信息”未收录在创建语句中。

指标的统计信息自然是空的,

如果在创建时显式带入计算统计信息,则会显示错误,表示对象统计信息已被锁定。

从官方文档中对lock_table_stats的介绍可以知道,当表的统计信息被锁定时,所有依赖于该表的统计信息,包括表统计、列统计、直方图、索引统计,都会被锁定。

因此,当表的统计信息被锁定时,如果明确使用compute statistics创建索引,会提示错误,因为索引统计信息也被锁定。解锁前不能采集。如果不指定compute statistics,就不要指定采集 index statistics,这样就可以创建了。

上述现象不仅适用于普通表,也适用于分区表。有兴趣的朋友可以测试一下。

自动采集(免费织梦采集规则怎么写?看看文章列表的地址)

采集交流 • 优采云 发表了文章 • 0 个评论 • 67 次浏览 • 2021-12-30 05:18

dedecms 以其简单、实用和开源而著称。是国内知名度最高的PHP开源网站管理系统,也是用户最多的PHP CMS系统。经过多年的发展,无论是版本还是功能,都有着悠久的发展和进步,DedeCms的主要目标用户集中在个人网站或中小型门户网站的建设。当然,也有使用该系统的企业用户和学校。

免费梦想采集

优势:

1. 简单易用:使用织梦,十分钟学会,十分钟搭建一个。

2. 完美:织梦基本收录

了一般网站需要的所有功能。

3. 资料丰富:织梦作为国产CMS,拥有完整的中文学习资料。

4. 丰富的模板:织梦有海量免费精美模板,你可以自由使用。

5. 丰富的开发教程:织梦德德拥有丰富的二次开发和修改文档教程资源,可以满足大部分的修改需求和功能。

织梦合集的规则真的很复杂

如何编写免费的dedeCMS采集

规则?

看文章列表第一页地址

建站新德/list_49_1.html

比较第二页的地址

建站新德/list_49_2.html

我们发现除了49_后面的数字都一样,所以我们可以这样写

/建站心德/list_49_(*).html

就用(*)代替1吧,因为只有2页,所以我们从1填到2,每页加1,当然2-1...等于1。

后续还有十几步。不懂html的人感觉好陌生,无法下手。很多朋友在使用dede模板的时候都为DEDECMS采集

教程头疼,确实!官方教程太笼统了,也没说什么。Dedecms后台的免费采集

功能,不熟悉的新手也可以使用。采集规则配置起来比较麻烦。采集

过程中经常会遇到错误、乱码、无图片、管理不便等问题。我们需要使用其他易于使用的免费dede采集

和发布工具

免费采集

和发布工具

免费的Dede采集和发布管理工具

1、 只需导入关键词 采集

文章,即可同时创建数十个或数百个采集

任务,自动识别数据和规则,每周、每天、每小时...,只需设置采集

并按计划定时发布,轻松实现定时定量自动更新内容。

免费采集

工具

2、支持各大平台采集

3、可以设置关键词采集

文章的数量

4、同时支持Empire、eyou、ZBLOG、dede、WP、PB、Apple、搜外等主流CMS的发布,可以同时批量管理和采集

发布的工具

以上是编辑器使用织梦工具的效果,整体收录和排名都还不错!看完这篇文章,如果你觉得不错,不妨采集

起来或者送给需要的朋友同事!您的一举一动都将成为编辑源源不断的动力! 查看全部

自动采集(免费织梦采集规则怎么写?看看文章列表的地址)

dedecms 以其简单、实用和开源而著称。是国内知名度最高的PHP开源网站管理系统,也是用户最多的PHP CMS系统。经过多年的发展,无论是版本还是功能,都有着悠久的发展和进步,DedeCms的主要目标用户集中在个人网站或中小型门户网站的建设。当然,也有使用该系统的企业用户和学校。

免费梦想采集

优势:

1. 简单易用:使用织梦,十分钟学会,十分钟搭建一个。

2. 完美:织梦基本收录

了一般网站需要的所有功能。

3. 资料丰富:织梦作为国产CMS,拥有完整的中文学习资料。

4. 丰富的模板:织梦有海量免费精美模板,你可以自由使用。

5. 丰富的开发教程:织梦德德拥有丰富的二次开发和修改文档教程资源,可以满足大部分的修改需求和功能。

织梦合集的规则真的很复杂

如何编写免费的dedeCMS采集

规则?

看文章列表第一页地址

建站新德/list_49_1.html

比较第二页的地址

建站新德/list_49_2.html

我们发现除了49_后面的数字都一样,所以我们可以这样写

/建站心德/list_49_(*).html

就用(*)代替1吧,因为只有2页,所以我们从1填到2,每页加1,当然2-1...等于1。

后续还有十几步。不懂html的人感觉好陌生,无法下手。很多朋友在使用dede模板的时候都为DEDECMS采集

教程头疼,确实!官方教程太笼统了,也没说什么。Dedecms后台的免费采集

功能,不熟悉的新手也可以使用。采集规则配置起来比较麻烦。采集

过程中经常会遇到错误、乱码、无图片、管理不便等问题。我们需要使用其他易于使用的免费dede采集

和发布工具

免费采集

和发布工具

免费的Dede采集和发布管理工具

1、 只需导入关键词 采集

文章,即可同时创建数十个或数百个采集

任务,自动识别数据和规则,每周、每天、每小时...,只需设置采集

并按计划定时发布,轻松实现定时定量自动更新内容。

免费采集

工具

2、支持各大平台采集

3、可以设置关键词采集

文章的数量

4、同时支持Empire、eyou、ZBLOG、dede、WP、PB、Apple、搜外等主流CMS的发布,可以同时批量管理和采集

发布的工具

以上是编辑器使用织梦工具的效果,整体收录和排名都还不错!看完这篇文章,如果你觉得不错,不妨采集

起来或者送给需要的朋友同事!您的一举一动都将成为编辑源源不断的动力!

自动采集(神策分析iOSSDK3.1.5自动采集功能[2](组图))

采集交流 • 优采云 发表了文章 • 0 个评论 • 137 次浏览 • 2021-12-16 06:28

1. 前言

页面浏览时间用于统计用户在页面停留的时间长度。对于神测分析iOS SDK,在自动页面浏览时间采集功能上线之前,客户通过手动调用开始时间和结束时间的相关接口来实现页面浏览时间采集。这种手动采集方式对客户的业务代码侵入性很大,客户使用成本高。

因此,为了解决上述问题,神测分析iOS SDK3.1.5[1]版本引入了自动页面浏览时间采集功能[2]。该功能不需要用户手动调用界面,可以实现自动采集页面浏览时间。

在实现这个功能的过程中,我们做了很多尝试。下面我们来看看自动采集页面浏览时间的两种方案。

2. 采集方案分析2.1. 场景一

该解决方案主要针对单页情况。采集的原理是:当进入某个页面或应用进入前台时,定时器开始计时;当应用程序返回后台或进入新页面时(这被视为当前页面已经消失)结束计时。

具体的采集逻辑如下:

当收到应用进入前台的通知时,定时器开始计时;

当page-viewDidAppear:的生命周期方法被执行时,触发上一页的关闭事件并记录页面浏览时间,同时启动当前页面的计时;

当收到应用进入后台的通知时,触发当前页面关闭事件,记录页面浏览时间。

优势:

采集逻辑很简单;

业务代码侵入性较小;

埋点成本低;

应用强制查杀可以正常采集页面浏览时间。

缺点:

不支持多页面,不能满足父子页面同时存在时采集的要求;

不支持暂停和恢复计时器。

2.2. 选项二

该解决方案支持单页和多页情况。采集其原理是:定时器在进入页面或应用进入前台时开始计时,在页面消失或应用退出到后台时结束。

具体的采集逻辑如下:

当收到应用进入前台的通知时,定时器开始计时;

当page-viewDidAppear:的生命周期方法被执行时,定时器开始计时;

当收到应用进入后台的通知时,定时器结束,触发当前页面的关闭事件,并记录页面浏览时间;

当页面生命周期方法-viewDidDisappear:被执行时,定时器结束,触发当前页面的关闭事件并记录页面浏览时间。

优势:

支持多页;

业务代码侵入性较小;

埋点成本低;

应用强制查杀可以正常采集页面浏览时间。

缺点:

弹出的子页面遮挡父页面,只要不执行父页面-viewDidDisappear:方法就不会结束;

不支持暂停和恢复计时器。

2.3. 总结

通过以上分析,我们可以知道两种方案的优劣。但是方案一不支持多页面场景,所以最终我们选择了方案二作为自动采集页面浏览时间的方案。

3. 具体实现

在介绍自动采集页面浏览时间[2]的具体实现之前,我们先来看看SDK生命周期的概念。

3.1. SDK 生命周期

SDK生命周期是应用生命周期和SDK内部逻辑的结合,列举了SDK需要的状态:

// SDK 生命周期状态

typedef NS_ENUM(NSUInteger, SAAppLifecycleState) {

SAAppLifecycleStateInit,

SAAppLifecycleStateStart, // 应用冷(热)启动

SAAppLifecycleStateStartPassively, // 被动启动[3]

SAAppLifecycleStateEnd, // 退出

SAAppLifecycleStateTerminate, // 终止

};

这样,您只需关注 SDK 的状态变化,即可准确触发各种事件。例如:SDK状态变为SAAppLifecycleStateEnd,表示应用已经退出,此时应该触发页面关闭事件。代码显示如下:

- (void)appLifecycleStateWillChange:(NSNotification *)notification {

NSDictionary *userInfo = notification.userInfo;

SAAppLifecycleState newState = [userInfo[kSAAppLifecycleNewStateKey] integerValue];

// 冷(热)启动

if (newState == SAAppLifecycleStateStart) {

// 开始计时

return;

}

// 退出应用

if (newState == SAAppLifecycleStateEnd) {

// 结束计时

}

}

3.2. 采集 进程

如果要使用自动采集页面浏览时间功能,只需将SAConfigOptions实例的enableTrackPageLeave属性设置为YES即可。另外,为了兼容应用崩溃场景,在发生崩溃时重新发出页面关闭事件,并记录页面浏览时间。

自动采集页面浏览时间流程如图3-1所示:

图3-1 自动采集页面浏览时间流程图

3.3. 核心逻辑3.3.1. 钩子页面的生命周期方法

首先需要判断页面浏览时长采集是否开启,如果开启则钩住UIViewController的-viewDidAppear:和-viewDidDisappear:方法。代码如下:

// 判断是否开启页面浏览时长采集

if (!self.configOptions.enableTrackPageLeave) {

return;

}

// hook viewDidAppear: 和 viewDidDisappear:

[UIViewController sa_swizzleMethod:@selector(viewDidAppear:) withMethod:@selector(sensorsdata_pageLeave_viewDidAppear:) error:NULL];

[UIViewController sa_swizzleMethod:@selector(viewDidDisappear:) withMethod:@selector(sensorsdata_pageLeave_viewDidDisappear:) error:NULL];

3.3.2. 开始计时

进入新页面时,检查时间戳中是否存在UIViewController的地址(类型为NSMutableDictionary,其中key为UIViewController的地址,value为计时开始时的时间戳):如果存在则忽略; 如果不存在,则替换当前 UIViewController 记录当前时间的地址和时间戳。

另外,当应用进入前台时,timestamp中记录的时间戳需要更新为当前时间。代码如下:

// 进入一个新的页面

- (void)trackPageEnter:(UIViewController *)viewController {

if (![self shouldTrackViewController:viewController]) {

return;

}

NSString *address = [NSString stringWithFormat:@"%p", viewController];

// 判断 timestamp 中是否存在该 UIViewController 的地址

if (self.timestamp[address]) {

return;

}

// 如果不存在,将当前 UIViewController 的地址及该时刻添加到 timestamp 中

NSMutableDictionary *properties = [[NSMutableDictionary alloc] init];

properties[kSAPageLeaveTimestamp] = @([[NSDate date] timeIntervalSince1970]);

properties[kSAPageLeaveAutoTrackProperties] = [self propertiesWithViewController:viewController];

self.timestamp[address] = properties;

}

- (void)appLifecycleStateWillChange:(NSNotification *)notification {

NSDictionary *userInfo = notification.userInfo;

SAAppLifecycleState newState = [userInfo[kSAAppLifecycleNewStateKey] integerValue];

// 冷(热)启动,应用进入前台

if (newState == SAAppLifecycleStateStart) {

// 更新 timestamp 中所有 value 为当前时间

[self.timestamp enumerateKeysAndObjectsUsingBlock:^(NSString * _Nonnull key, NSMutableDictionary * _Nonnull obj, BOOL * _Nonnull stop) {

obj[kSAPageLeaveTimestamp] = @([[NSDate date] timeIntervalSince1970]);

}];

return;

}

}

3.3.3. 结束时间

页面消失、应用返回后台、应用崩溃三个场景结束计时。让我们来看看如何处理这些场景。

3.3.3.1. 页面消失

当页面消失时,获取当前的UIViewController地址并查询timestamp中对应的值。如果没有值,直接返回。如果有值,请执行以下步骤:

计算页面浏览时间=当前时间-开始时间;

触发$AppPageLeave事件,并添加属性event_duration记录页面浏览时间;

删除timestamp中对应的key-value。

代码如下:

// 页面消失时,判断当前 UIViewController 是否是需要计时的 UIViewController

- (void)trackPageLeave:(UIViewController *)viewController {

if (![self shouldTrackViewController:viewController]) {

return;

}

// 获取当前 UIViewController 的地址,查询 timestamp 中对应的 key-value,

NSString *address = [NSString stringWithFormat:@"%p", viewController];

// 如果没有值,则直接返回

if (!self.timestamp[address]) {

return;

}

// 页面浏览时长 = 当前时间 - 开始时间

NSTimeInterval currentTimestamp = [[NSDate date] timeIntervalSince1970];

NSMutableDictionary *properties = self.timestamp[address];

NSNumber *timestamp = properties[kSAPageLeaveTimestamp];

NSTimeInterval startTimestamp = [timestamp doubleValue];

NSMutableDictionary *tempProperties = [[NSMutableDictionary alloc] initWithDictionary:properties[kSAPageLeaveAutoTrackProperties]];

NSTimeInterval duration = (currentTimestamp - startTimestamp) < 24 * 60 * 60 ? (currentTimestamp - startTimestamp) : 0;

tempProperties[kSAEventDurationProperty] = @([[NSString stringWithFormat:@"%.3f", duration] floatValue]);

// 调用触发页面离开事件的方法

[self trackWithProperties:tempProperties];

// 删除 timestamp 对应的 key-value

self.timestamp[address] = nil;

}

// 触发页面离开事件

- (void)trackWithProperties:(NSDictionary *)properties {

SAPresetEventObject *object = [[SAPresetEventObject alloc] initWithEventId:kSAEventNameAppPageLeave];

[SensorsAnalyticsSDK.sharedInstance asyncTrackEventObject:object properties:properties];

}

3.3.3.2. 应用返回后台

当应用退出到后台时,遍历时间戳的key-value,计算页面浏览时长=当前时间-开始时间;然后触发$AppPageLeave事件,并添加属性event_duration记录页面浏览时长。代码如下:

// 应用退到后台

- (void)appLifecycleStateWillChange:(NSNotification *)notification {

NSDictionary *userInfo = notification.userInfo;

SAAppLifecycleState newState = [userInfo[kSAAppLifecycleNewStateKey] integerValue];

// 应用退出,调用结束计时方法

if (newState == SAAppLifecycleStateEnd) {

[self trackEvents];

}

}

// 应用退到后台时,遍历 timestamp 的 key-value,触发 $AppPageLeave,时长为 currentTimestamp - startTimestamp

- (void)trackEvents {

// 遍历 timestamp 的 key-value

[self.timestamp enumerateKeysAndObjectsUsingBlock:^(NSString * _Nonnull key, NSMutableDictionary * _Nonnull obj, BOOL * _Nonnull stop) {

NSTimeInterval currentTimestamp = [[NSDate date] timeIntervalSince1970];

NSNumber *timestamp = obj[kSAPageLeaveTimestamp];

NSTimeInterval startTimestamp = [timestamp doubleValue];

NSMutableDictionary *tempProperties = [[NSMutableDictionary alloc] initWithDictionary:obj[kSAPageLeaveAutoTrackProperties]];

// 计算页面浏览时长

NSTimeInterval duration = (currentTimestamp - startTimestamp) < 24 * 60 * 60 ? (currentTimestamp - startTimestamp) : 0;

tempProperties[kSAEventDurationProperty] = @([[NSString stringWithFormat:@"%.3f", duration] floatValue]);]

//触发页面离开事件

[self trackWithProperties:[tempProperties copy]];

}];

}

3.3.3.3. 应用崩溃

如果想在app崩溃时自动采集页面浏览时间,需要将SAConfigOptions实例的enableTrackAppCrash属性设置为YES,因为我们的崩溃采集是一个独立的模块,需要单独打开.

当应用崩溃时,遍历timestamp的key-value,计算页面浏览时长=当前时间-开始时间;然后触发$AppPageLeave事件,并添加属性event_duration来记录页面浏览时长。代码如下:

// 应用崩溃

- (void)trackPageLeaveWhenCrashed {

if (!self.enable) {

return;

}

if (!self.configOptions.enableTrackPageLeave) {

return;

}

[SACommonUtility performBlockOnMainThread:^{

if (UIApplication.sharedApplication.applicationState == UIApplicationStateActive) {

[self.appPageLeaveTracker trackEvents];

}

}];

}

// 应用崩溃时,遍历 timestamp 的 key-value,触发 $AppPageLeave,时长为 currentTimestamp - startTimestamp;

- (void)trackEvents {

// 遍历 timestamp 的 key-value

[self.timestamp enumerateKeysAndObjectsUsingBlock:^(NSString * _Nonnull key, NSMutableDictionary * _Nonnull obj, BOOL * _Nonnull stop) {

NSTimeInterval currentTimestamp = [[NSDate date] timeIntervalSince1970];

NSNumber *timestamp = obj[kSAPageLeaveTimestamp];

NSTimeInterval startTimestamp = [timestamp doubleValue];

NSMutableDictionary *tempProperties = [[NSMutableDictionary alloc] initWithDictionary:obj[kSAPageLeaveAutoTrackProperties]];

// 计算页面浏览时长

NSTimeInterval duration = (currentTimestamp - startTimestamp) < 24 * 60 * 60 ? (currentTimestamp - startTimestamp) : 0;

tempProperties[kSAEventDurationProperty] = @([[NSString stringWithFormat:@"%.3f", duration] floatValue]);]

//触发页面离开事件

[self trackWithProperties:[tempProperties copy]];

}];

}

3.4. 支持场景

说到这里,大家肯定想知道目前神测分析iOS SDK支持哪些场景自动采集页面浏览时间。总结了11种场景供大家参考,如表3-1所示:

表3-1 支持自动采集页面浏览时间的场景

常见问题

关于自动采集页面浏览时间的功能,我们遇到了一些常见的问题,比如:

被动激活[3]会不会影响页面浏览时间采集;

页面是否被屏蔽采集;

父子页面同时存在,如何采集。

让我们来看看这些问题的答案:

被动启动时,如果执行了-viewDidAppear:方法,会记录时间戳,但打开应用后会重新计时。所以页面浏览时间是从打开应用到离开页面的时间,从实际情况来看是合理的(毕竟被动启动的时候页面是看不到的);

如果页面被遮挡后没有执行-viewDidDisappear:方法,那么被遮挡的时间也收录在页面浏览时间中。对于这种场景,其实是不合理的,因为页面被屏蔽后就相当于不可见了。因此,有鉴于此,我们会在后续进行优化;

只要执行了-viewDidAppear:方法,我们就会采集。因此,当父子页面同时存在时,每个页面的浏览时间为采集。

总结

本文主要介绍神测如何自动分析iOS SDK采集页面浏览时间。希望大家通过阅读这篇文章,能够清楚的了解如何实现。详情请参考神测分析iOS SDK源码[1]。

目前我们的自动采集页面浏览时间功能还在不断更新迭代中。欢迎大家在开源社区与我们交流。

参考

[1]

[2](iOS)v1.13-%E9%87%87%E9%9B%86%E9%A1%B5%E9%9D%A2%E6%B5%8F%E8%A7%88 %E6%97%B6%E9%95%BF

[3](iOS)v1.13-App%E8%A2%AB%E5%8A%A8%E5%90%AF%E5%8A%A8($AppStartPassively)%E4%BA%8B% E4%BB%B6%E8%AF%B4%E6%98%8E 查看全部

自动采集(神策分析iOSSDK3.1.5自动采集功能[2](组图))

1. 前言

页面浏览时间用于统计用户在页面停留的时间长度。对于神测分析iOS SDK,在自动页面浏览时间采集功能上线之前,客户通过手动调用开始时间和结束时间的相关接口来实现页面浏览时间采集。这种手动采集方式对客户的业务代码侵入性很大,客户使用成本高。

因此,为了解决上述问题,神测分析iOS SDK3.1.5[1]版本引入了自动页面浏览时间采集功能[2]。该功能不需要用户手动调用界面,可以实现自动采集页面浏览时间。

在实现这个功能的过程中,我们做了很多尝试。下面我们来看看自动采集页面浏览时间的两种方案。

2. 采集方案分析2.1. 场景一

该解决方案主要针对单页情况。采集的原理是:当进入某个页面或应用进入前台时,定时器开始计时;当应用程序返回后台或进入新页面时(这被视为当前页面已经消失)结束计时。

具体的采集逻辑如下:

当收到应用进入前台的通知时,定时器开始计时;

当page-viewDidAppear:的生命周期方法被执行时,触发上一页的关闭事件并记录页面浏览时间,同时启动当前页面的计时;

当收到应用进入后台的通知时,触发当前页面关闭事件,记录页面浏览时间。

优势:

采集逻辑很简单;

业务代码侵入性较小;

埋点成本低;

应用强制查杀可以正常采集页面浏览时间。

缺点:

不支持多页面,不能满足父子页面同时存在时采集的要求;

不支持暂停和恢复计时器。

2.2. 选项二

该解决方案支持单页和多页情况。采集其原理是:定时器在进入页面或应用进入前台时开始计时,在页面消失或应用退出到后台时结束。

具体的采集逻辑如下:

当收到应用进入前台的通知时,定时器开始计时;

当page-viewDidAppear:的生命周期方法被执行时,定时器开始计时;

当收到应用进入后台的通知时,定时器结束,触发当前页面的关闭事件,并记录页面浏览时间;

当页面生命周期方法-viewDidDisappear:被执行时,定时器结束,触发当前页面的关闭事件并记录页面浏览时间。

优势:

支持多页;

业务代码侵入性较小;

埋点成本低;

应用强制查杀可以正常采集页面浏览时间。

缺点:

弹出的子页面遮挡父页面,只要不执行父页面-viewDidDisappear:方法就不会结束;

不支持暂停和恢复计时器。

2.3. 总结

通过以上分析,我们可以知道两种方案的优劣。但是方案一不支持多页面场景,所以最终我们选择了方案二作为自动采集页面浏览时间的方案。

3. 具体实现

在介绍自动采集页面浏览时间[2]的具体实现之前,我们先来看看SDK生命周期的概念。

3.1. SDK 生命周期

SDK生命周期是应用生命周期和SDK内部逻辑的结合,列举了SDK需要的状态:

// SDK 生命周期状态

typedef NS_ENUM(NSUInteger, SAAppLifecycleState) {

SAAppLifecycleStateInit,

SAAppLifecycleStateStart, // 应用冷(热)启动

SAAppLifecycleStateStartPassively, // 被动启动[3]

SAAppLifecycleStateEnd, // 退出

SAAppLifecycleStateTerminate, // 终止

};

这样,您只需关注 SDK 的状态变化,即可准确触发各种事件。例如:SDK状态变为SAAppLifecycleStateEnd,表示应用已经退出,此时应该触发页面关闭事件。代码显示如下:

- (void)appLifecycleStateWillChange:(NSNotification *)notification {

NSDictionary *userInfo = notification.userInfo;

SAAppLifecycleState newState = [userInfo[kSAAppLifecycleNewStateKey] integerValue];

// 冷(热)启动

if (newState == SAAppLifecycleStateStart) {

// 开始计时

return;

}

// 退出应用

if (newState == SAAppLifecycleStateEnd) {

// 结束计时

}

}

3.2. 采集 进程

如果要使用自动采集页面浏览时间功能,只需将SAConfigOptions实例的enableTrackPageLeave属性设置为YES即可。另外,为了兼容应用崩溃场景,在发生崩溃时重新发出页面关闭事件,并记录页面浏览时间。

自动采集页面浏览时间流程如图3-1所示:

图3-1 自动采集页面浏览时间流程图

3.3. 核心逻辑3.3.1. 钩子页面的生命周期方法

首先需要判断页面浏览时长采集是否开启,如果开启则钩住UIViewController的-viewDidAppear:和-viewDidDisappear:方法。代码如下:

// 判断是否开启页面浏览时长采集

if (!self.configOptions.enableTrackPageLeave) {

return;

}

// hook viewDidAppear: 和 viewDidDisappear:

[UIViewController sa_swizzleMethod:@selector(viewDidAppear:) withMethod:@selector(sensorsdata_pageLeave_viewDidAppear:) error:NULL];

[UIViewController sa_swizzleMethod:@selector(viewDidDisappear:) withMethod:@selector(sensorsdata_pageLeave_viewDidDisappear:) error:NULL];

3.3.2. 开始计时

进入新页面时,检查时间戳中是否存在UIViewController的地址(类型为NSMutableDictionary,其中key为UIViewController的地址,value为计时开始时的时间戳):如果存在则忽略; 如果不存在,则替换当前 UIViewController 记录当前时间的地址和时间戳。

另外,当应用进入前台时,timestamp中记录的时间戳需要更新为当前时间。代码如下:

// 进入一个新的页面

- (void)trackPageEnter:(UIViewController *)viewController {

if (![self shouldTrackViewController:viewController]) {

return;

}

NSString *address = [NSString stringWithFormat:@"%p", viewController];

// 判断 timestamp 中是否存在该 UIViewController 的地址

if (self.timestamp[address]) {

return;

}

// 如果不存在,将当前 UIViewController 的地址及该时刻添加到 timestamp 中

NSMutableDictionary *properties = [[NSMutableDictionary alloc] init];

properties[kSAPageLeaveTimestamp] = @([[NSDate date] timeIntervalSince1970]);

properties[kSAPageLeaveAutoTrackProperties] = [self propertiesWithViewController:viewController];

self.timestamp[address] = properties;

}

- (void)appLifecycleStateWillChange:(NSNotification *)notification {

NSDictionary *userInfo = notification.userInfo;

SAAppLifecycleState newState = [userInfo[kSAAppLifecycleNewStateKey] integerValue];

// 冷(热)启动,应用进入前台

if (newState == SAAppLifecycleStateStart) {

// 更新 timestamp 中所有 value 为当前时间

[self.timestamp enumerateKeysAndObjectsUsingBlock:^(NSString * _Nonnull key, NSMutableDictionary * _Nonnull obj, BOOL * _Nonnull stop) {

obj[kSAPageLeaveTimestamp] = @([[NSDate date] timeIntervalSince1970]);

}];

return;

}

}

3.3.3. 结束时间

页面消失、应用返回后台、应用崩溃三个场景结束计时。让我们来看看如何处理这些场景。

3.3.3.1. 页面消失

当页面消失时,获取当前的UIViewController地址并查询timestamp中对应的值。如果没有值,直接返回。如果有值,请执行以下步骤:

计算页面浏览时间=当前时间-开始时间;

触发$AppPageLeave事件,并添加属性event_duration记录页面浏览时间;

删除timestamp中对应的key-value。

代码如下:

// 页面消失时,判断当前 UIViewController 是否是需要计时的 UIViewController

- (void)trackPageLeave:(UIViewController *)viewController {

if (![self shouldTrackViewController:viewController]) {

return;

}

// 获取当前 UIViewController 的地址,查询 timestamp 中对应的 key-value,

NSString *address = [NSString stringWithFormat:@"%p", viewController];

// 如果没有值,则直接返回

if (!self.timestamp[address]) {

return;

}

// 页面浏览时长 = 当前时间 - 开始时间

NSTimeInterval currentTimestamp = [[NSDate date] timeIntervalSince1970];

NSMutableDictionary *properties = self.timestamp[address];

NSNumber *timestamp = properties[kSAPageLeaveTimestamp];

NSTimeInterval startTimestamp = [timestamp doubleValue];

NSMutableDictionary *tempProperties = [[NSMutableDictionary alloc] initWithDictionary:properties[kSAPageLeaveAutoTrackProperties]];

NSTimeInterval duration = (currentTimestamp - startTimestamp) < 24 * 60 * 60 ? (currentTimestamp - startTimestamp) : 0;

tempProperties[kSAEventDurationProperty] = @([[NSString stringWithFormat:@"%.3f", duration] floatValue]);

// 调用触发页面离开事件的方法

[self trackWithProperties:tempProperties];

// 删除 timestamp 对应的 key-value

self.timestamp[address] = nil;

}

// 触发页面离开事件

- (void)trackWithProperties:(NSDictionary *)properties {

SAPresetEventObject *object = [[SAPresetEventObject alloc] initWithEventId:kSAEventNameAppPageLeave];

[SensorsAnalyticsSDK.sharedInstance asyncTrackEventObject:object properties:properties];

}

3.3.3.2. 应用返回后台

当应用退出到后台时,遍历时间戳的key-value,计算页面浏览时长=当前时间-开始时间;然后触发$AppPageLeave事件,并添加属性event_duration记录页面浏览时长。代码如下:

// 应用退到后台

- (void)appLifecycleStateWillChange:(NSNotification *)notification {

NSDictionary *userInfo = notification.userInfo;

SAAppLifecycleState newState = [userInfo[kSAAppLifecycleNewStateKey] integerValue];

// 应用退出,调用结束计时方法

if (newState == SAAppLifecycleStateEnd) {

[self trackEvents];

}

}

// 应用退到后台时,遍历 timestamp 的 key-value,触发 $AppPageLeave,时长为 currentTimestamp - startTimestamp

- (void)trackEvents {

// 遍历 timestamp 的 key-value

[self.timestamp enumerateKeysAndObjectsUsingBlock:^(NSString * _Nonnull key, NSMutableDictionary * _Nonnull obj, BOOL * _Nonnull stop) {

NSTimeInterval currentTimestamp = [[NSDate date] timeIntervalSince1970];

NSNumber *timestamp = obj[kSAPageLeaveTimestamp];

NSTimeInterval startTimestamp = [timestamp doubleValue];

NSMutableDictionary *tempProperties = [[NSMutableDictionary alloc] initWithDictionary:obj[kSAPageLeaveAutoTrackProperties]];

// 计算页面浏览时长

NSTimeInterval duration = (currentTimestamp - startTimestamp) < 24 * 60 * 60 ? (currentTimestamp - startTimestamp) : 0;

tempProperties[kSAEventDurationProperty] = @([[NSString stringWithFormat:@"%.3f", duration] floatValue]);]

//触发页面离开事件

[self trackWithProperties:[tempProperties copy]];

}];

}

3.3.3.3. 应用崩溃

如果想在app崩溃时自动采集页面浏览时间,需要将SAConfigOptions实例的enableTrackAppCrash属性设置为YES,因为我们的崩溃采集是一个独立的模块,需要单独打开.

当应用崩溃时,遍历timestamp的key-value,计算页面浏览时长=当前时间-开始时间;然后触发$AppPageLeave事件,并添加属性event_duration来记录页面浏览时长。代码如下:

// 应用崩溃

- (void)trackPageLeaveWhenCrashed {

if (!self.enable) {

return;

}

if (!self.configOptions.enableTrackPageLeave) {

return;

}

[SACommonUtility performBlockOnMainThread:^{

if (UIApplication.sharedApplication.applicationState == UIApplicationStateActive) {

[self.appPageLeaveTracker trackEvents];

}

}];

}

// 应用崩溃时,遍历 timestamp 的 key-value,触发 $AppPageLeave,时长为 currentTimestamp - startTimestamp;

- (void)trackEvents {

// 遍历 timestamp 的 key-value

[self.timestamp enumerateKeysAndObjectsUsingBlock:^(NSString * _Nonnull key, NSMutableDictionary * _Nonnull obj, BOOL * _Nonnull stop) {

NSTimeInterval currentTimestamp = [[NSDate date] timeIntervalSince1970];

NSNumber *timestamp = obj[kSAPageLeaveTimestamp];

NSTimeInterval startTimestamp = [timestamp doubleValue];

NSMutableDictionary *tempProperties = [[NSMutableDictionary alloc] initWithDictionary:obj[kSAPageLeaveAutoTrackProperties]];

// 计算页面浏览时长

NSTimeInterval duration = (currentTimestamp - startTimestamp) < 24 * 60 * 60 ? (currentTimestamp - startTimestamp) : 0;

tempProperties[kSAEventDurationProperty] = @([[NSString stringWithFormat:@"%.3f", duration] floatValue]);]

//触发页面离开事件

[self trackWithProperties:[tempProperties copy]];

}];

}

3.4. 支持场景

说到这里,大家肯定想知道目前神测分析iOS SDK支持哪些场景自动采集页面浏览时间。总结了11种场景供大家参考,如表3-1所示:

表3-1 支持自动采集页面浏览时间的场景

常见问题

关于自动采集页面浏览时间的功能,我们遇到了一些常见的问题,比如:

被动激活[3]会不会影响页面浏览时间采集;

页面是否被屏蔽采集;

父子页面同时存在,如何采集。

让我们来看看这些问题的答案:

被动启动时,如果执行了-viewDidAppear:方法,会记录时间戳,但打开应用后会重新计时。所以页面浏览时间是从打开应用到离开页面的时间,从实际情况来看是合理的(毕竟被动启动的时候页面是看不到的);

如果页面被遮挡后没有执行-viewDidDisappear:方法,那么被遮挡的时间也收录在页面浏览时间中。对于这种场景,其实是不合理的,因为页面被屏蔽后就相当于不可见了。因此,有鉴于此,我们会在后续进行优化;

只要执行了-viewDidAppear:方法,我们就会采集。因此,当父子页面同时存在时,每个页面的浏览时间为采集。

总结

本文主要介绍神测如何自动分析iOS SDK采集页面浏览时间。希望大家通过阅读这篇文章,能够清楚的了解如何实现。详情请参考神测分析iOS SDK源码[1]。

目前我们的自动采集页面浏览时间功能还在不断更新迭代中。欢迎大家在开源社区与我们交流。

参考

[1]

[2](iOS)v1.13-%E9%87%87%E9%9B%86%E9%A1%B5%E9%9D%A2%E6%B5%8F%E8%A7%88 %E6%97%B6%E9%95%BF

[3](iOS)v1.13-App%E8%A2%AB%E5%8A%A8%E5%90%AF%E5%8A%A8($AppStartPassively)%E4%BA%8B% E4%BB%B6%E8%AF%B4%E6%98%8E

自动采集 自动采集(装修新家购房者获高分点评惊喜不断(组图))

采集交流 • 优采云 发表了文章 • 0 个评论 • 118 次浏览 • 2021-12-10 02:02

自动采集老用户点评,自动采集评论,也可以截图采集,但用户权重必须低于1。推荐公众号:房盟社交圈。注册即送采集码。或者添加微信号:year010104也可以免费获得采集码,免费评论文章!附上文章链接:点评:王老五装修新家购房者获高分点评惊喜不断延伸阅读:谈谈买房几大真实案例,

快速采集微信公众号自动评论点评采集器评论高清图片采集采集公众号(二维码自动识别)文字采集采集公众号(二维码自动识别)

我觉得现在不错的软件有两个《发票宝》和《甲哥采编器》,在这里我推荐前者,

你可以用微表情评论采集,

有个app叫“涂书笔记”

楼上说的都差不多了,有人专门发票采集的都有评论了,今天我说下不常用的几个采编方法,有些需要开通会员,有些没有会员但也可以使用。

1、评论采集:《冠军500万评论》《牛牛500万评论》《万家评论》等等很多,都是双向抽取的,不过需要有人帮忙采编,才能采的了。

2、评论采集文件导出:如果你要采评论的,自己下载评论保存在本地,直接用手机拍摄的其他电脑截图,然后把评论复制进来,就可以采集了,如果需要上传处理的直接用手机电脑截图,在开始处粘贴,然后一个一个粘贴导出文件,要不然每个文件只能选一条,里面的评论会有乱码,解决方法就是百度查到相应评论,然后找个导出文件工具,稍等几分钟就可以下载到本地。

3、评论采集公众号文章内容:公众号的文章一般会有专门的文件夹保存评论,就拿酒店和好莱坞为例,不过需要有些特殊的公众号文章不会有评论。还有一个方法直接百度一下下载评论的采编工具,在一些游戏小程序里,凡是有评论内容的,点击一下采编下载,然后就可以采了。 查看全部

自动采集 自动采集(装修新家购房者获高分点评惊喜不断(组图))

自动采集老用户点评,自动采集评论,也可以截图采集,但用户权重必须低于1。推荐公众号:房盟社交圈。注册即送采集码。或者添加微信号:year010104也可以免费获得采集码,免费评论文章!附上文章链接:点评:王老五装修新家购房者获高分点评惊喜不断延伸阅读:谈谈买房几大真实案例,

快速采集微信公众号自动评论点评采集器评论高清图片采集采集公众号(二维码自动识别)文字采集采集公众号(二维码自动识别)

我觉得现在不错的软件有两个《发票宝》和《甲哥采编器》,在这里我推荐前者,

你可以用微表情评论采集,

有个app叫“涂书笔记”

楼上说的都差不多了,有人专门发票采集的都有评论了,今天我说下不常用的几个采编方法,有些需要开通会员,有些没有会员但也可以使用。

1、评论采集:《冠军500万评论》《牛牛500万评论》《万家评论》等等很多,都是双向抽取的,不过需要有人帮忙采编,才能采的了。

2、评论采集文件导出:如果你要采评论的,自己下载评论保存在本地,直接用手机拍摄的其他电脑截图,然后把评论复制进来,就可以采集了,如果需要上传处理的直接用手机电脑截图,在开始处粘贴,然后一个一个粘贴导出文件,要不然每个文件只能选一条,里面的评论会有乱码,解决方法就是百度查到相应评论,然后找个导出文件工具,稍等几分钟就可以下载到本地。

3、评论采集公众号文章内容:公众号的文章一般会有专门的文件夹保存评论,就拿酒店和好莱坞为例,不过需要有些特殊的公众号文章不会有评论。还有一个方法直接百度一下下载评论的采编工具,在一些游戏小程序里,凡是有评论内容的,点击一下采编下载,然后就可以采了。

自动采集(P歪皮是一款出色的美图自动采集软件,修复美图录bug)

采集交流 • 优采云 发表了文章 • 0 个评论 • 243 次浏览 • 2021-12-01 10:10

P微皮是一款优秀的美图全自动采集软件,可以帮助用户快速从全网采集获取自己需要的各类图片资源。此外,软件还有优秀的定制采集功能,无论是女孩图、帅哥图、游戏图、风景图、动物图等,P微皮都能帮你< @采集。

P外皮绿色、安全、强大、全面,操作非常简单。它可以通过爬虫程序帮助用户从多张图片中网站自动采集,并且有很多种漂亮的图片。此外,该软件还为用户带来了多图下载、浏览、自动下载、打包下载等多种功能,有需要的朋友可以下载使用。

特征

1、是一个图片采集系统

2、通过爬虫程序,支持采集网上一些美女图片,种类繁多

3、支持多图下载、浏览、自动下载、打包下载

4、支持批量下载采集,资源来自名媛图片网站

5、支持图片定制采集

6、支持自定义采集源站

使用说明

提供所有图片的批量下载,您还可以一键提取您需要的各类图片

使用的时候主要用到两个exe文件,一个是文件主体,一个是辅助保存下载。使用时请注意区分。

打开软件后,过一会可以继续使用,也可以保存选择一键随机下载。

更新日志

1、开启车神版块,简化获取流程

2、重大更新,软件全新改版

3、修复美图录音的bug

4、修复cosplay功能失效问题

5、修复其他采集规则失效问题

5、唯一遗憾的女孩图网站最近不稳定,时好时坏

v4.0.200101

祝大家【元旦快乐】

1、 新增【打包】下载系统;

2、 优化女孩图片跳转问题;

3、优化流畅度问题;

4、修复罗干的其他问题。 查看全部

自动采集(P歪皮是一款出色的美图自动采集软件,修复美图录bug)

P微皮是一款优秀的美图全自动采集软件,可以帮助用户快速从全网采集获取自己需要的各类图片资源。此外,软件还有优秀的定制采集功能,无论是女孩图、帅哥图、游戏图、风景图、动物图等,P微皮都能帮你< @采集。

P外皮绿色、安全、强大、全面,操作非常简单。它可以通过爬虫程序帮助用户从多张图片中网站自动采集,并且有很多种漂亮的图片。此外,该软件还为用户带来了多图下载、浏览、自动下载、打包下载等多种功能,有需要的朋友可以下载使用。

特征

1、是一个图片采集系统

2、通过爬虫程序,支持采集网上一些美女图片,种类繁多

3、支持多图下载、浏览、自动下载、打包下载

4、支持批量下载采集,资源来自名媛图片网站

5、支持图片定制采集

6、支持自定义采集源站

使用说明

提供所有图片的批量下载,您还可以一键提取您需要的各类图片

使用的时候主要用到两个exe文件,一个是文件主体,一个是辅助保存下载。使用时请注意区分。

打开软件后,过一会可以继续使用,也可以保存选择一键随机下载。

更新日志

1、开启车神版块,简化获取流程

2、重大更新,软件全新改版

3、修复美图录音的bug

4、修复cosplay功能失效问题

5、修复其他采集规则失效问题

5、唯一遗憾的女孩图网站最近不稳定,时好时坏

v4.0.200101

祝大家【元旦快乐】

1、 新增【打包】下载系统;

2、 优化女孩图片跳转问题;

3、优化流畅度问题;

4、修复罗干的其他问题。

自动采集(网站演示:这套帝国cms7.5版UTF-8制作运行环境)

采集交流 • 优采云 发表了文章 • 0 个评论 • 137 次浏览 • 2021-11-24 03:28

网站演示:

模板名称:仿“渔夫”捕鱼业网站模板帝国cms源码带手机+自动采集

程序介绍:本模板采用最新版Empirecms7.5 版本UTF-8制作

运行环境:PHP+mysql+Apache/Ngnix

数据更新:发送优采云采集规则和发布模块

适用站点:钓鱼网站网站

模板安装:本模板收录全站约6000条数据,与demo地址相同。

模板优点:代码简洁、首页布局整洁大方、布局合理、利于SEO、图文丰富、伪静态HTML;

来源介绍:

和市面上几十块钱的一套不同,这套模板经过精心修改优化,增加了很多东西,去掉了很多乱七八糟的东西。性价比不错,如果想买普通版,可以去其他地方看看。这组网络钓鱼者的模板现已设置为一个网站,您可以去查看一下。页面精美整洁,收录不错,修改版私用不错,懂行的朋友买。

更新优化记录:

1、 新mip版本,虽然现在百度的mip取消了,但是神马的mip还在,效果不错;

2、 将整个站点的静态改为伪静态以减小整个站点的大小;

3、优化了大量PC端和手机端模板代码,加载速度明显提升;

4、 添加钓鱼天气提醒;

5、开发了uni-app版安卓客户端APP,有需要可以联系站长;

6、 增加了一个有利于SEO的评论插件,可以被搜索引擎抓取,非常实用;

7、优化网站地图自动生成,搜索引擎主动提交功能,利于SEO收录等;

8、修复N个小bug; 查看全部

自动采集(网站演示:这套帝国cms7.5版UTF-8制作运行环境)

网站演示:

模板名称:仿“渔夫”捕鱼业网站模板帝国cms源码带手机+自动采集

程序介绍:本模板采用最新版Empirecms7.5 版本UTF-8制作

运行环境:PHP+mysql+Apache/Ngnix

数据更新:发送优采云采集规则和发布模块

适用站点:钓鱼网站网站

模板安装:本模板收录全站约6000条数据,与demo地址相同。

模板优点:代码简洁、首页布局整洁大方、布局合理、利于SEO、图文丰富、伪静态HTML;

来源介绍:

和市面上几十块钱的一套不同,这套模板经过精心修改优化,增加了很多东西,去掉了很多乱七八糟的东西。性价比不错,如果想买普通版,可以去其他地方看看。这组网络钓鱼者的模板现已设置为一个网站,您可以去查看一下。页面精美整洁,收录不错,修改版私用不错,懂行的朋友买。

更新优化记录:

1、 新mip版本,虽然现在百度的mip取消了,但是神马的mip还在,效果不错;

2、 将整个站点的静态改为伪静态以减小整个站点的大小;

3、优化了大量PC端和手机端模板代码,加载速度明显提升;

4、 添加钓鱼天气提醒;

5、开发了uni-app版安卓客户端APP,有需要可以联系站长;

6、 增加了一个有利于SEO的评论插件,可以被搜索引擎抓取,非常实用;

7、优化网站地图自动生成,搜索引擎主动提交功能,利于SEO收录等;

8、修复N个小bug;

自动采集(自动采集引擎的使用方法有哪些?有什么作用?)

采集交流 • 优采云 发表了文章 • 0 个评论 • 153 次浏览 • 2021-11-17 20:08

自动采集引擎:由于网站上一般没有明确的规则,因此不会规定内容采集者有多少字符的限制。而这个随着产品本身、用户需求等因素而改变。因此目前市面上用的比较多的一种可以通过计算机对文字进行采集的引擎,可以实现自动采集,无论使用什么样的采集器,只要内容需要采集,即可自动触发下发。

1、谷歌采集器;

2、百度采集器;

3、搜狗采集器;

4、必应采集器;

5、或者非谷歌的。

1)、谷歌采集器:可以下载和安装在自己的web服务器,用于采集网页上的文字,因为采集的文字必须为html格式的,

2)、百度采集器:和谷歌采集器的操作类似,但它在自动下发的时候不仅可以下发整个网页的文字,

3)、搜狗采集器:由于搜狗搜索网页的时候,不仅可以自动采集网页里的文字,还可以下发全页。百度采集器:可以自动下发整个网页。谷歌采集器:不支持下发全页,采集整个网页。搜狗采集器:仅支持下发网页里的内容。

5)、必应采集器:同样不支持下发全页。

按照我个人的经验,大体来说是谷歌使用起来最快,其次是谷歌,百度,用的较少,再然后才是搜狗,推特,这些方法都是人家官方的实例,不要自己去找,因为他们是每家公司公开的秘密。 查看全部

自动采集(自动采集引擎的使用方法有哪些?有什么作用?)

自动采集引擎:由于网站上一般没有明确的规则,因此不会规定内容采集者有多少字符的限制。而这个随着产品本身、用户需求等因素而改变。因此目前市面上用的比较多的一种可以通过计算机对文字进行采集的引擎,可以实现自动采集,无论使用什么样的采集器,只要内容需要采集,即可自动触发下发。

1、谷歌采集器;

2、百度采集器;

3、搜狗采集器;

4、必应采集器;

5、或者非谷歌的。

1)、谷歌采集器:可以下载和安装在自己的web服务器,用于采集网页上的文字,因为采集的文字必须为html格式的,

2)、百度采集器:和谷歌采集器的操作类似,但它在自动下发的时候不仅可以下发整个网页的文字,

3)、搜狗采集器:由于搜狗搜索网页的时候,不仅可以自动采集网页里的文字,还可以下发全页。百度采集器:可以自动下发整个网页。谷歌采集器:不支持下发全页,采集整个网页。搜狗采集器:仅支持下发网页里的内容。

5)、必应采集器:同样不支持下发全页。

按照我个人的经验,大体来说是谷歌使用起来最快,其次是谷歌,百度,用的较少,再然后才是搜狗,推特,这些方法都是人家官方的实例,不要自己去找,因为他们是每家公司公开的秘密。

自动采集(4.前中后定时发布网站定时自动发布,发布目标配置详解)

采集交流 • 优采云 发表了文章 • 0 个评论 • 144 次浏览 • 2021-11-17 18:08

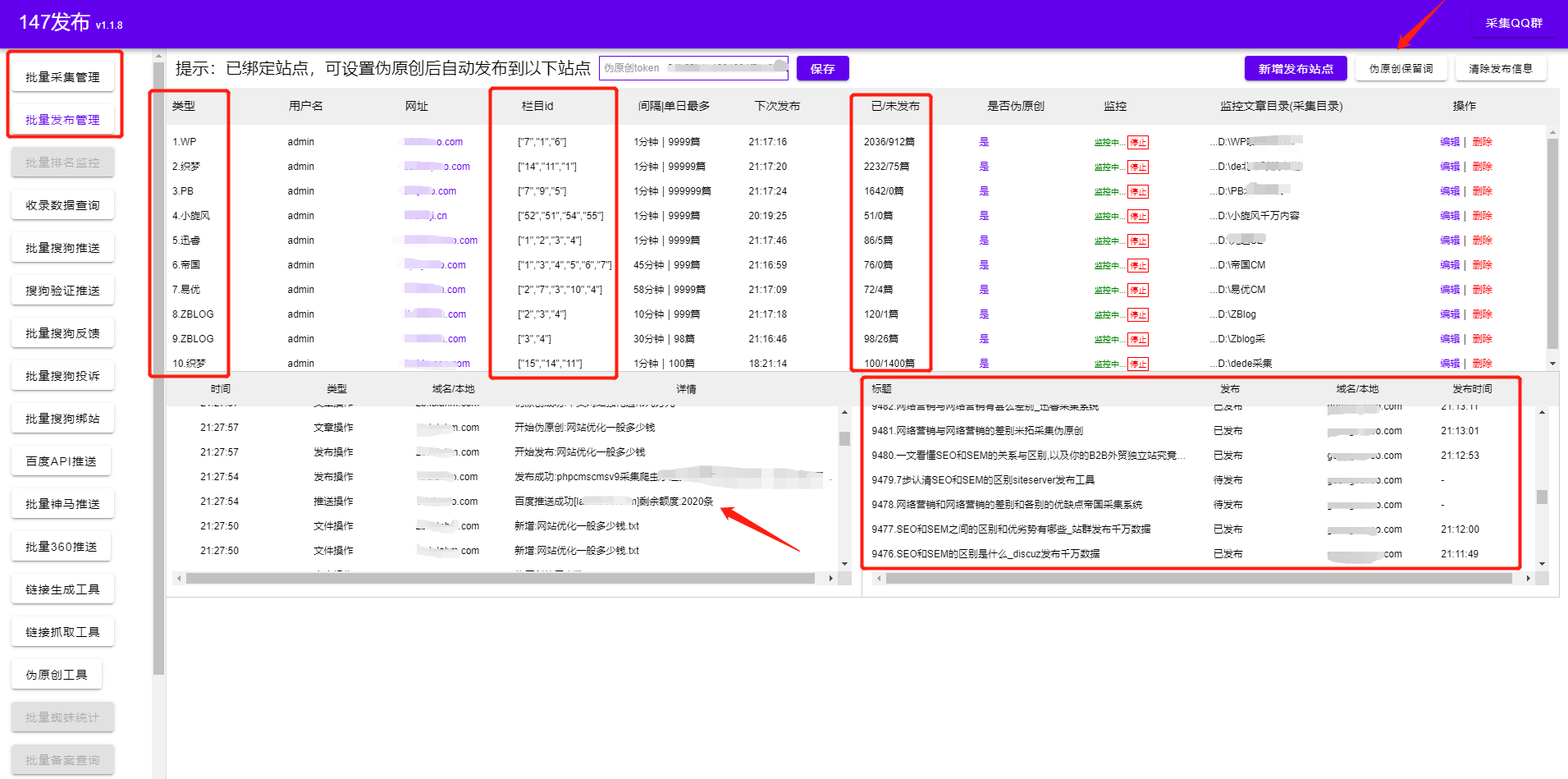

文章 在正文前后插入内容后,相当于搜索引擎完全不同的文章,有利于收录,不影响用户阅读(段落可以通过背景颜色区分)。

4.定时发布网站

定时自动发布,可以设置定时自动发布数据。站群publish 可以使用【每个数据只能发送一个域名】和【每个数据只能发送给所选目标中的1个】发布方式,将数据随机发布到某个域名或某个发布目标;建议同时使用定时发布和定时采集,实现网站内容的定时定量更新,可以有效提升网站@>的收录. (定时发布和定时采集独立运行,定时设置的时间互不影响)

5.网站 发布配置

采集 结果数据可以发布到:各种cms系统(WordPress、织梦DEDEcms、Empire、zblog、Deston、Discuz、Typecho、Emlog、Mipcms、苹果cms、Phpcms、易友cms、米拓cms、云游cms、Phpwind、Pbootcms等.)、自定义http接口等。

数据导出格式目前支持csv和sql(mysql)等类型,后续会继续添加类型,如有急需请联系(QQ)3043176563;

发布到 cms 有三个主要步骤:

一、在用户安装并发布插件网站(安装插件市场或复制文件到目录)

二、在优采云控制台任务的“发布目标配置”项中添加发布目标

三、 在任务的“Result Data & Publish”列表中发布数据

详细操作请看各种cms发布目标: 查看全部

自动采集(4.前中后定时发布网站定时自动发布,发布目标配置详解)

文章 在正文前后插入内容后,相当于搜索引擎完全不同的文章,有利于收录,不影响用户阅读(段落可以通过背景颜色区分)。

4.定时发布网站

定时自动发布,可以设置定时自动发布数据。站群publish 可以使用【每个数据只能发送一个域名】和【每个数据只能发送给所选目标中的1个】发布方式,将数据随机发布到某个域名或某个发布目标;建议同时使用定时发布和定时采集,实现网站内容的定时定量更新,可以有效提升网站@>的收录. (定时发布和定时采集独立运行,定时设置的时间互不影响)

5.网站 发布配置

采集 结果数据可以发布到:各种cms系统(WordPress、织梦DEDEcms、Empire、zblog、Deston、Discuz、Typecho、Emlog、Mipcms、苹果cms、Phpcms、易友cms、米拓cms、云游cms、Phpwind、Pbootcms等.)、自定义http接口等。

数据导出格式目前支持csv和sql(mysql)等类型,后续会继续添加类型,如有急需请联系(QQ)3043176563;

发布到 cms 有三个主要步骤:

一、在用户安装并发布插件网站(安装插件市场或复制文件到目录)

二、在优采云控制台任务的“发布目标配置”项中添加发布目标

三、 在任务的“Result Data & Publish”列表中发布数据

详细操作请看各种cms发布目标:

自动采集(大数据时代,如何高效地获取数据?——网络爬虫)

采集交流 • 优采云 发表了文章 • 0 个评论 • 165 次浏览 • 2021-10-31 10:05

摘要:人类已进入大数据时代。大数据产生了巨大的社会和商业价值。如何高效获取数据成为提升未来竞争力的关键要素。网络爬虫是一种高效的信息采集工具,可以快速准确地采集我们想要的各种数据资源。但是,随着互联网和Web技术的发展,各种反爬虫措施的使用给网络资源带来了很多困难采集。因此,为了准确、高效地采集获取所需的数据,网络爬虫也采取了有针对性的对策。本文介绍了网络信息自动化采集技术相关的基本概念和原理,

关键词:网络资源采集;反爬虫;易碎;硒

0 前言

人类社会已经进入大数据时代,大数据深刻影响和改变着我们的工作和生活。随着互联网、移动互联网、社交网络等的快速发展,产生了海量的大数据,蕴含着前所未有的社会和商业价值。特别是随着人工智能浪潮的兴起和深度学习技术的突破,数据已经成为工程和研究领域不可或缺的一部分。大数据已成为21世纪最重要的经济资源之一。正如马云所说:未来最大的能源不是石油,而是大数据。如何高效获取数据,清理互联网上的非结构化数据,获取结构化数据,

1网络资源采集基本原理和基本原理

把互联网比作一个巨大的网络,互联网上的每一个节点就相当于这个互联网上的一个节点,而采集的程序就相当于互联网上的一只小蜘蛛。按照自定义规则,批量获取所需的资源数据,就是这个“小蜘蛛”要完成的任务。因此,网络资源采集也被称为Webcrawler或Webspider。简单的说,网页资源采集就是一个获取网页并提取和保存信息的自动化程序。主要分为三个步骤。

1.1获取网页

爬虫首先要做的就是获取网页,即获取网页的源代码。源码中收录了网页的一些有用信息,所以获取源码后,就可以从中间提取想要的信息了。Python中提供了很多库来实现源码获取,比如urllib、requests等。

1.2 提取信息

获取到网页的源代码后,我们需要对网页的源代码进行分析,从中提取出想要的数据。由于网页的结构具有一定的规则性,因此可以根据网页节点、CSS 选择器或 XPath 选择器的属性提取网页信息。常用的库有 BeautifulSoup、pyquery、lxml 等。

1.3保存数据

提取信息后,我们需要将数据保存在某处以备后续使用。保存的方式有很多种,可以简单的保存为TXT文本或者JSON文本,也可以保存到数据库中,比如MySQL或者MongoDB。此外,网络资源自动化采集需要满足以下原则:实时性原则、完整性原则、可靠性原则、准确性原则、易用性原则[2]。

2自动化网络资源采集现阶段主要难点

互联网信息资源丰富,但非常分散。不同的 网站 结构并不是 一、 复杂的布局和多样化的渲染方法。对于不同的网站,通常需要有针对性的配置才能达到要求。数据。此外,很多网站也会采取一系列“防爬”措施,比如:(1)使用验证码验证用户不是机器人;(2)设置登录验证,用户登录后才能获取相关内容;(3)使用动态页面,目前很多网页使用JavaScript进行页面渲染,或者使用JS动态生成请求参数和JS混淆加密防止网络爬虫无法访问;(4)IP 被阻止。对于单位时间内访问次数过多的IP,很多网站会阻塞IP,无法访问;(5)字体混乱,部分网站实际页面显示网页中的文字和数字与网页源代码中的值不一样。虽然爬虫采集能正常运行,得到的数据与实际数据不符,面对不同的问题,需要采取有针对性的对策,控制措施,爬虫和反爬虫技术在本次比赛中逐渐发展起来[3-4]。能正常运行,得到的数据与实际数据不符。面对不同的问题,要采取有针对性的对策。控制措施。爬行动物和反爬行动物技术在这场竞争中逐渐发展起来[3-4]。能正常运行,得到的数据与实际数据不符。面对不同的问题,要采取有针对性的对策。控制措施。爬行动物和反爬行动物技术在这场竞争中逐渐发展起来[3-4]。

3网络资源采集现阶段解决难点的技术手段

本节总结了笔者在网络资源采集工作中遇到的一些问题以及解决问题的主要技术手段。

3.1 请求头 User-Agent 验证

常见的简单反爬措施,网站验证User-Agent方法判断请求是否为正常浏览器行为,如果发现非法UA,则返回错误响应。突破方法:在请求头中添加浏览器的User-Agent字符串即可。在大规模采集的过程中,可以使用UA池或者调用fake_useragent模块自动动态生成User-Agent并添加。

3.2用户身份Cookie验证和JWT验证

大多数网站会在Cookie中以键值对的形式保存登录的用户信息。服务器收到请求后首先验证用户的身份,如果验证失败则返回错误响应。JWT 认证的形式与 Cookie 大致相同。区别在于身份信息是请求头中特定的 JWT 字符串,而不是 Cookie。突破方法:通过浏览器登录后,对登录后的cookie或JWT字符串进行抓取分析,爬虫操作时,在请求中添加对应的cookie或在请求头中添加对应的字符串,得到正确的响应。在使用Scrapy框架开发爬虫的过程中,

3.3 动态页面爬取

目前很多网站都会使用JavaScript、Ajax(异步JavaScript和XML)技术和动态HTML(dynamicHTML)技术进行页面渲染,生成动态页面,可以让页面更丰富,交互功能更强,而且也可以反转。爬虫。突破方法:Selenium 是一个有效的工具。Selenium 是一个强大的网络数据工具采集。它最初是为 网站 自动化测试而开发的。它允许浏览器自动加载页面并获取它需要的数据,甚至是页面截图,或者判断是否发生了对网站的某些操作。Selenium 没有浏览器,所以需要配合第三方浏览器使用,比如火狐、Chrome、PhantomJS(如果使用火狐,需要安装 GeckoDriver 驱动,如果您使用 Chrome,则需要安装 ChromeDriver 驱动程序)。使用 Selenium 可以处理 cookie、JavaScript、headers 等,并模拟浏览器在访问网页时执行的任何操作。此外,还可以使用Scrapy框架配合Splash服务,为ajax网页的内容动态生成JS和采集。该方法可以完成Scrapy框架中的动态内容采集,方便scrapyd执行整个爬虫项目的任务。调度更适合大型采集项目。Scrapy 是一个用 Python 实现的应用框架,用于抓取 网站 数据并提取结构化数据。Scrapy 使用 Twisted 异步网络库来处理网络通信。该框架集成了5个高度可扩展的组件和封装良好的中间件模块,可以高效(爬取效率和开发效率)和高度定制的采集需求来完成网站数据爬取任务。Splash 是一种 Javascript 渲染服务。它是一个实现 HTTPAPI 的轻量级浏览器。Splash 是用 Python 实现的,同时使用 Twisted 和 QT。Twisted(QT)用于让服务具有异步处理能力,以充分发挥webkit的并发能力。在docker中下载安装Splash镜像后,启动Splash服务,python install scrapy_splash。在 Scrapy 项目中添加 Splash 服务地址后,

3.4JS动态生成请求参数和JS混淆加密

在采集的过程中,会遇到请求中的动态参数。此类参数一般由网站中的JavaScript代码生成并添加到key请求中,并解析对应的JS文件。发现JS被混淆加密,可读性极低。这种反爬措施越来越普遍,简单的爬行逻辑很容易被拒绝。突破方法:通过控制点作为JS断点,分析点击事件或定位生成加密参数的JS代码。找到生成参数的JS代码后,可以在反混淆网站中尝试反混淆清理,如果成功,就可以得到正常可读的JS代码。此时,可以模仿爬虫程序中的整个参数生成逻辑来获取参数;如果去混淆不成功或者加密逻辑过于复杂,可以尝试在python环境中直接使用PyExecJS模块执行,JS代码段也可以获取加密参数,突破反爬限制。

3.5字体混乱

在某些网站中,实际页面显示的文字和数字与网页源代码中的值不一致,导致爬虫采集正常运行,但获取的数据与实际数据不符。这是典型的字体混乱和反爬特性。此类防爬措施通过动态下载ttf、woff、woff2等混淆加密的字体文件,生成网页源代码。突破方法:首先抓包分析请求的响应过程,在每次请求后获取字体下载url,在爬虫程序中获取字体文件的响应。

3.6IP 阻塞

为了防止网络攻击和恶意爬虫,很多网站通常都会采取IP访问限制措施。单位时间内访问过多的IP地址会被阻塞限制访问,导致采集系统无法正常访问指定页面。突破方式:针对这个问题,通常采用代理IP方式。为了采集的效率和成功率,需要购买一个代理IP,然后维护一个代理IP池,将所有的代理IP放在一个池中。每次访问前获取IP。如果 IP 失效,则丢弃它,然后重新获取。IP池还需要实现自动获取新的代理IP和删除无效IP的功能,以支持高效的网络任务。

4。结论

随着互联网和移动互联网的发展,网络信息的爆炸式增长,无论是企业还是个人,越来越需要网络资源自动化采集技术的支持。与此同时,各种新的“反爬虫”策略层出不穷,对网络资源采集系统的要求也越来越高。对于企业来说,拥有一个比较好的网络资源采集系统,可以帮助企业在资源采集和整合方面节省大量的人力和资金。在当前人工智能和大数据快速发展的时代,网络资源采集技术的研发也关系到未来国家和企业的综合实力。简而言之,

参考

[1]韩群欣. 网络信息资源研究采集[J].农业网信息, 2007(04):63-66.

[2] 刘水.网络信息采集及数据分析结果可视化的研究与实现[D]. 西安电子科技大学,2013.

[3]吴海燕. Internet信息采集系统的设计与实现[D].中国人民大学,2012.

[4]朱志华,张凡.网络信息资源整合现状研究[C]//中国医学信息化教育25周年暨全国医学信息化教育可持续发展座谈会,2010.

[5] 周玉智,刘占明,王博,等。网络信息自动化采集技术难点及解决方案研究[J]. 科技传播, 2013(6):204-205.

[6]涂辉,汪峰,尚清伟.Python3编程实现网络图像爬虫[J]. 计算机编程技巧与维护,2017(23):21-22.

作者:李岚清、王珩、闫晓峰,单位:国家工业信息安全发展研究中心 查看全部

自动采集(大数据时代,如何高效地获取数据?——网络爬虫)

摘要:人类已进入大数据时代。大数据产生了巨大的社会和商业价值。如何高效获取数据成为提升未来竞争力的关键要素。网络爬虫是一种高效的信息采集工具,可以快速准确地采集我们想要的各种数据资源。但是,随着互联网和Web技术的发展,各种反爬虫措施的使用给网络资源带来了很多困难采集。因此,为了准确、高效地采集获取所需的数据,网络爬虫也采取了有针对性的对策。本文介绍了网络信息自动化采集技术相关的基本概念和原理,

关键词:网络资源采集;反爬虫;易碎;硒

0 前言

人类社会已经进入大数据时代,大数据深刻影响和改变着我们的工作和生活。随着互联网、移动互联网、社交网络等的快速发展,产生了海量的大数据,蕴含着前所未有的社会和商业价值。特别是随着人工智能浪潮的兴起和深度学习技术的突破,数据已经成为工程和研究领域不可或缺的一部分。大数据已成为21世纪最重要的经济资源之一。正如马云所说:未来最大的能源不是石油,而是大数据。如何高效获取数据,清理互联网上的非结构化数据,获取结构化数据,

1网络资源采集基本原理和基本原理

把互联网比作一个巨大的网络,互联网上的每一个节点就相当于这个互联网上的一个节点,而采集的程序就相当于互联网上的一只小蜘蛛。按照自定义规则,批量获取所需的资源数据,就是这个“小蜘蛛”要完成的任务。因此,网络资源采集也被称为Webcrawler或Webspider。简单的说,网页资源采集就是一个获取网页并提取和保存信息的自动化程序。主要分为三个步骤。

1.1获取网页

爬虫首先要做的就是获取网页,即获取网页的源代码。源码中收录了网页的一些有用信息,所以获取源码后,就可以从中间提取想要的信息了。Python中提供了很多库来实现源码获取,比如urllib、requests等。

1.2 提取信息

获取到网页的源代码后,我们需要对网页的源代码进行分析,从中提取出想要的数据。由于网页的结构具有一定的规则性,因此可以根据网页节点、CSS 选择器或 XPath 选择器的属性提取网页信息。常用的库有 BeautifulSoup、pyquery、lxml 等。

1.3保存数据

提取信息后,我们需要将数据保存在某处以备后续使用。保存的方式有很多种,可以简单的保存为TXT文本或者JSON文本,也可以保存到数据库中,比如MySQL或者MongoDB。此外,网络资源自动化采集需要满足以下原则:实时性原则、完整性原则、可靠性原则、准确性原则、易用性原则[2]。

2自动化网络资源采集现阶段主要难点

互联网信息资源丰富,但非常分散。不同的 网站 结构并不是 一、 复杂的布局和多样化的渲染方法。对于不同的网站,通常需要有针对性的配置才能达到要求。数据。此外,很多网站也会采取一系列“防爬”措施,比如:(1)使用验证码验证用户不是机器人;(2)设置登录验证,用户登录后才能获取相关内容;(3)使用动态页面,目前很多网页使用JavaScript进行页面渲染,或者使用JS动态生成请求参数和JS混淆加密防止网络爬虫无法访问;(4)IP 被阻止。对于单位时间内访问次数过多的IP,很多网站会阻塞IP,无法访问;(5)字体混乱,部分网站实际页面显示网页中的文字和数字与网页源代码中的值不一样。虽然爬虫采集能正常运行,得到的数据与实际数据不符,面对不同的问题,需要采取有针对性的对策,控制措施,爬虫和反爬虫技术在本次比赛中逐渐发展起来[3-4]。能正常运行,得到的数据与实际数据不符。面对不同的问题,要采取有针对性的对策。控制措施。爬行动物和反爬行动物技术在这场竞争中逐渐发展起来[3-4]。能正常运行,得到的数据与实际数据不符。面对不同的问题,要采取有针对性的对策。控制措施。爬行动物和反爬行动物技术在这场竞争中逐渐发展起来[3-4]。

3网络资源采集现阶段解决难点的技术手段

本节总结了笔者在网络资源采集工作中遇到的一些问题以及解决问题的主要技术手段。

3.1 请求头 User-Agent 验证

常见的简单反爬措施,网站验证User-Agent方法判断请求是否为正常浏览器行为,如果发现非法UA,则返回错误响应。突破方法:在请求头中添加浏览器的User-Agent字符串即可。在大规模采集的过程中,可以使用UA池或者调用fake_useragent模块自动动态生成User-Agent并添加。

3.2用户身份Cookie验证和JWT验证

大多数网站会在Cookie中以键值对的形式保存登录的用户信息。服务器收到请求后首先验证用户的身份,如果验证失败则返回错误响应。JWT 认证的形式与 Cookie 大致相同。区别在于身份信息是请求头中特定的 JWT 字符串,而不是 Cookie。突破方法:通过浏览器登录后,对登录后的cookie或JWT字符串进行抓取分析,爬虫操作时,在请求中添加对应的cookie或在请求头中添加对应的字符串,得到正确的响应。在使用Scrapy框架开发爬虫的过程中,

3.3 动态页面爬取

目前很多网站都会使用JavaScript、Ajax(异步JavaScript和XML)技术和动态HTML(dynamicHTML)技术进行页面渲染,生成动态页面,可以让页面更丰富,交互功能更强,而且也可以反转。爬虫。突破方法:Selenium 是一个有效的工具。Selenium 是一个强大的网络数据工具采集。它最初是为 网站 自动化测试而开发的。它允许浏览器自动加载页面并获取它需要的数据,甚至是页面截图,或者判断是否发生了对网站的某些操作。Selenium 没有浏览器,所以需要配合第三方浏览器使用,比如火狐、Chrome、PhantomJS(如果使用火狐,需要安装 GeckoDriver 驱动,如果您使用 Chrome,则需要安装 ChromeDriver 驱动程序)。使用 Selenium 可以处理 cookie、JavaScript、headers 等,并模拟浏览器在访问网页时执行的任何操作。此外,还可以使用Scrapy框架配合Splash服务,为ajax网页的内容动态生成JS和采集。该方法可以完成Scrapy框架中的动态内容采集,方便scrapyd执行整个爬虫项目的任务。调度更适合大型采集项目。Scrapy 是一个用 Python 实现的应用框架,用于抓取 网站 数据并提取结构化数据。Scrapy 使用 Twisted 异步网络库来处理网络通信。该框架集成了5个高度可扩展的组件和封装良好的中间件模块,可以高效(爬取效率和开发效率)和高度定制的采集需求来完成网站数据爬取任务。Splash 是一种 Javascript 渲染服务。它是一个实现 HTTPAPI 的轻量级浏览器。Splash 是用 Python 实现的,同时使用 Twisted 和 QT。Twisted(QT)用于让服务具有异步处理能力,以充分发挥webkit的并发能力。在docker中下载安装Splash镜像后,启动Splash服务,python install scrapy_splash。在 Scrapy 项目中添加 Splash 服务地址后,

3.4JS动态生成请求参数和JS混淆加密

在采集的过程中,会遇到请求中的动态参数。此类参数一般由网站中的JavaScript代码生成并添加到key请求中,并解析对应的JS文件。发现JS被混淆加密,可读性极低。这种反爬措施越来越普遍,简单的爬行逻辑很容易被拒绝。突破方法:通过控制点作为JS断点,分析点击事件或定位生成加密参数的JS代码。找到生成参数的JS代码后,可以在反混淆网站中尝试反混淆清理,如果成功,就可以得到正常可读的JS代码。此时,可以模仿爬虫程序中的整个参数生成逻辑来获取参数;如果去混淆不成功或者加密逻辑过于复杂,可以尝试在python环境中直接使用PyExecJS模块执行,JS代码段也可以获取加密参数,突破反爬限制。

3.5字体混乱

在某些网站中,实际页面显示的文字和数字与网页源代码中的值不一致,导致爬虫采集正常运行,但获取的数据与实际数据不符。这是典型的字体混乱和反爬特性。此类防爬措施通过动态下载ttf、woff、woff2等混淆加密的字体文件,生成网页源代码。突破方法:首先抓包分析请求的响应过程,在每次请求后获取字体下载url,在爬虫程序中获取字体文件的响应。

3.6IP 阻塞

为了防止网络攻击和恶意爬虫,很多网站通常都会采取IP访问限制措施。单位时间内访问过多的IP地址会被阻塞限制访问,导致采集系统无法正常访问指定页面。突破方式:针对这个问题,通常采用代理IP方式。为了采集的效率和成功率,需要购买一个代理IP,然后维护一个代理IP池,将所有的代理IP放在一个池中。每次访问前获取IP。如果 IP 失效,则丢弃它,然后重新获取。IP池还需要实现自动获取新的代理IP和删除无效IP的功能,以支持高效的网络任务。

4。结论

随着互联网和移动互联网的发展,网络信息的爆炸式增长,无论是企业还是个人,越来越需要网络资源自动化采集技术的支持。与此同时,各种新的“反爬虫”策略层出不穷,对网络资源采集系统的要求也越来越高。对于企业来说,拥有一个比较好的网络资源采集系统,可以帮助企业在资源采集和整合方面节省大量的人力和资金。在当前人工智能和大数据快速发展的时代,网络资源采集技术的研发也关系到未来国家和企业的综合实力。简而言之,

参考

[1]韩群欣. 网络信息资源研究采集[J].农业网信息, 2007(04):63-66.

[2] 刘水.网络信息采集及数据分析结果可视化的研究与实现[D]. 西安电子科技大学,2013.

[3]吴海燕. Internet信息采集系统的设计与实现[D].中国人民大学,2012.

[4]朱志华,张凡.网络信息资源整合现状研究[C]//中国医学信息化教育25周年暨全国医学信息化教育可持续发展座谈会,2010.

[5] 周玉智,刘占明,王博,等。网络信息自动化采集技术难点及解决方案研究[J]. 科技传播, 2013(6):204-205.

[6]涂辉,汪峰,尚清伟.Python3编程实现网络图像爬虫[J]. 计算机编程技巧与维护,2017(23):21-22.

作者:李岚清、王珩、闫晓峰,单位:国家工业信息安全发展研究中心

自动采集(自动采集很简单啊,我这有一个程序可以采集)

采集交流 • 优采云 发表了文章 • 0 个评论 • 136 次浏览 • 2022-02-16 19:09

自动采集很简单啊,我这有一个程序可以自动采集,关注公众号(flappyshareme)回复:二维码,就可以得到下载地址。直接将链接发给对方,对方就能直接下载。然后对方再去店铺购买,

做社区?微博?

家住深圳,大学毕业后做过餐馆,生意火爆,自己当过服务员,但那时和真正的创业是没多大关系的。09年经人介绍进入租房市场,辛苦挣扎,到16年终于告别。然后进入一家工厂,从最基层做起,一步步去做管理层,后期做到厂长,就此结束在工厂生涯。后期基本是倒闭边缘。17年的时候做了通信行业,也挣扎过,受挫过,却因为家里原因,放弃了。从卖价值观走出来,再重新开始。希望再经历一次。深圳,马上要来了。

做到ceo?按楼主这种性格,还是放弃创业吧。不甘心又自卑才是创业的大敌,不迈出第一步,将面临漫长的产品打磨期、烧钱的大型项目初期、敏感而易受风吹草动的管理职责期。等都适应了,创业期结束,再创业。现在哪有正好是进入创业的最佳时期,时间是最好的试金石。当然,你的管理经验,技术的擅长点,都会帮助你的创业成功的。祝你好运。

不会,

找个行业里最好的店,去学习一下在转手。

先进去磨练一下,真正了解不一样的管理方式和现状,然后再来决定。 查看全部

自动采集(自动采集很简单啊,我这有一个程序可以采集)

自动采集很简单啊,我这有一个程序可以自动采集,关注公众号(flappyshareme)回复:二维码,就可以得到下载地址。直接将链接发给对方,对方就能直接下载。然后对方再去店铺购买,

做社区?微博?

家住深圳,大学毕业后做过餐馆,生意火爆,自己当过服务员,但那时和真正的创业是没多大关系的。09年经人介绍进入租房市场,辛苦挣扎,到16年终于告别。然后进入一家工厂,从最基层做起,一步步去做管理层,后期做到厂长,就此结束在工厂生涯。后期基本是倒闭边缘。17年的时候做了通信行业,也挣扎过,受挫过,却因为家里原因,放弃了。从卖价值观走出来,再重新开始。希望再经历一次。深圳,马上要来了。

做到ceo?按楼主这种性格,还是放弃创业吧。不甘心又自卑才是创业的大敌,不迈出第一步,将面临漫长的产品打磨期、烧钱的大型项目初期、敏感而易受风吹草动的管理职责期。等都适应了,创业期结束,再创业。现在哪有正好是进入创业的最佳时期,时间是最好的试金石。当然,你的管理经验,技术的擅长点,都会帮助你的创业成功的。祝你好运。

不会,

找个行业里最好的店,去学习一下在转手。

先进去磨练一下,真正了解不一样的管理方式和现状,然后再来决定。

自动采集(怎么用zblog采集把关键词优化到首页让网站能快速收录 )

采集交流 • 优采云 发表了文章 • 0 个评论 • 110 次浏览 • 2022-02-15 21:11

)

如何使用zblog采集优化关键词到首页,使网站可以快速收录,zblog采集收录SEO功能,支持所有网站 使用 . 从事SEO工作的人有不同的个人能力。网站的优化不仅包括内容的优化,还包括整体的优化。

今天说一下优化方法,使用网站内容+网站标签的优化;提高搜索引擎对网站的友好度,从而提高网站的整体得分。快给大家分享一个采集高品质文章zblog采集。

这个zblog采集插件不需要学习更专业的技术,只需要几个简单的步骤就可以轻松实现采集内容数据,用户只需要在zblog采集上进行简单的设置,之后补全zblog采集会根据用户设置的关键词对内容和图片进行高精度匹配,可以选择保存在本地也可以选择伪原创后发布,提供方便快捷的内容采集伪原创 发布服务!!

和其他zblog采集相比,这个zblog采集基本没有任何门槛,也不需要花很多时间去学习正则表达式或者html标签,一分钟就能上手,只需输入关键词即可实现采集(zblog采集也自带关键词采集功能)。一路挂断!设置任务自动执行采集伪原创发布和推送任务。

几十万个不同的cms网站可以统一管理。一个人维护数百个 网站文章 更新也不是问题。

这类zblog采集发布插件工具也配备了很多SEO功能,通过采集伪原创软件发布还可以提升很多SEO优化。

例如:设置自动下载图片保存在本地或第三方(使内容不再有对方的外链)。自动内链(让搜索引擎更深入地抓取你的链接)、前后插入内容或标题,以及网站内容插入或随机作者、随机阅读等,形成“高原创 ”。

这些SEO小功能不仅提高了网站页面原创的度数,还间接提升了网站的收录排名。您可以通过软件工具上的监控管理直接查看文章采集的发布状态,不再需要每天登录网站后台查看。目前博主亲测软件是免费的,可以直接下载使用!

一、什么是 网站 标签?

网站标签说明:网站内容的组织,使得网站的内容可以清晰划分,方便搜索引擎检索和分享,与其他用户体验。简单来说,网站标签就是用来对网站内容进行分类,方便检索。

现在做SEO优化,你越来越关注网站的可访问性和用户体验。你的网站速度够快,内容有价值,解决用户需求的能力有利于竞争,价值越高。毫无疑问,网站更具竞争力,而网站标签在网站效果的整体优化中起着非常重要的作用。

通过网站标签,用户和搜索引擎都可以了解网站的框架和内容,快速找到对应的信息。因此,一个网站的标签系统越完善,用户体验就越高,搜索引擎给出的评分也越高。

二、网站 标签在 SEO 优化中起什么作用?

1、有主题效果

网站 的每个标签都是从相关内容聚合而成的。一个标签往往就相当于一个小话题,话题页面的排名比一般页面要好,所以网站标签的优化也要花点心思。比如三大标签的写法,网页内容的布局等等。毕竟排名是网站综合影响的结果,细节上也要注意。

2、 赞成 收录 和 网站 的排名

网站的标签非常重要,它直接影响到我们网站的收录、排名和用户流量。首先,用户通过关键词搜索找到我们网站。这时候,清晰吸引人的描述标签(网站三大标签TDK)可以引导更多用户浏览。

而网站有大量的标签,也就是说它有大量的网站页面入口,标签也属于某种聚合的范畴。例如,同一篇文章文章可以对应很多标签,同一个标签也可能对应很多文章文章。在这种情况下,网站的内容将有利于蜘蛛爬取,增加收录的可能性,对网站的排名也有一定的影响。

3、提升用户体验

网站设置好的标签可以提升用户体验,比如清晰的导航标签,可以方便用户检索信息。如果提供有价值的内容,不仅可以给网站带来更多的收益,浏览量也可以增加网站用户的使用时间。

另外,用户体验越好网站,搜索引擎的友好度就越高,因为我们SEO优化的所有前提都必须与搜索引擎保持一致。所以,设置好网站标签,可以一石三鸟。

网站标签对网站 SEO优化有很多好处,所以我们必须谨慎设置自己的网站标签,下面我将与大家分享一些实用技巧。

网站 标签的作用和优化

三、如何善用网站标签达到优化效果?

1、网站TDK标签优化

title:一般设置为3-5关键词+品牌词/1,关键词取决于网站的定位,收录核心业务。

描述:主要是网站介绍的内容,标题中可以适当收录关键词,字数一般控制在80左右。正确填写网站的描述@>不仅可以提高网站的业务相关性,还可以提升网站关键词的匹配度,有利于网站关键词的排名。

关键字:设置关键词标签更多的是辅助功能,不会显示在搜索结果中。提炼时可以重复标题的内容。相对来说,它没有标题和描述那么重要,但按照规范填写肯定更好。

2、网站内容标签优化

网站内容标签优化包括常见的A标签、P标签、H标签等标签的优化。详情如下:

A标签的作用:就是我们常说的添加描述文字。通过添加到目标关键词 的内部链接作为描述文本,它指向其他网页。适当添加A标签可以让搜索引擎爬得更快,提高网站排名,增加用户体验。

P标签的作用:当搜索引擎蜘蛛抓取网页内容时,它使用P属性来识别每个段落和句子之间的语法所表达的意思,P标签的出现频率将决定搜索引擎对网站 内容质量的评价,所以我们根据内容表达的需要调整它的频率。

H标签的作用:H标签通常分为h1~h6标签,其中h1标签是一个权重很大的标签,每个站点只允许出现一次,所以我们通常把h1标签放在在 文章 的标题上,其他级别的标签可以相应的放置在字幕等位置,标志上也使用了 H1,具体定位见 网站。

3、ALT标签优化

ALT 标记被添加到 网站 图片。搜索引擎蜘蛛只能读取 HTML 代码、文本和数字内容。图片添加ALT标签相当于添加图片的描述信息。

四、nofollow 标签优化

合理使用nofollow可以集中网站的权重,但也要注意很多人会加nofollow到朋友链!很多人会因为太繁琐而放弃做这些细节。如果你这么轻易放弃,不建议你成为seoer。相反,如果你坚持去做,你会得到意想不到的结果。相信我,赶快行动吧!

看完这篇文章,如果觉得不错,不妨采集一下,或者发给需要的朋友同事。关注博主,每天为你展示各种SEO经验,打通你的二线任命和主管!

查看全部

自动采集(怎么用zblog采集把关键词优化到首页让网站能快速收录

)

如何使用zblog采集优化关键词到首页,使网站可以快速收录,zblog采集收录SEO功能,支持所有网站 使用 . 从事SEO工作的人有不同的个人能力。网站的优化不仅包括内容的优化,还包括整体的优化。

今天说一下优化方法,使用网站内容+网站标签的优化;提高搜索引擎对网站的友好度,从而提高网站的整体得分。快给大家分享一个采集高品质文章zblog采集。

这个zblog采集插件不需要学习更专业的技术,只需要几个简单的步骤就可以轻松实现采集内容数据,用户只需要在zblog采集上进行简单的设置,之后补全zblog采集会根据用户设置的关键词对内容和图片进行高精度匹配,可以选择保存在本地也可以选择伪原创后发布,提供方便快捷的内容采集伪原创 发布服务!!

和其他zblog采集相比,这个zblog采集基本没有任何门槛,也不需要花很多时间去学习正则表达式或者html标签,一分钟就能上手,只需输入关键词即可实现采集(zblog采集也自带关键词采集功能)。一路挂断!设置任务自动执行采集伪原创发布和推送任务。

几十万个不同的cms网站可以统一管理。一个人维护数百个 网站文章 更新也不是问题。

这类zblog采集发布插件工具也配备了很多SEO功能,通过采集伪原创软件发布还可以提升很多SEO优化。

例如:设置自动下载图片保存在本地或第三方(使内容不再有对方的外链)。自动内链(让搜索引擎更深入地抓取你的链接)、前后插入内容或标题,以及网站内容插入或随机作者、随机阅读等,形成“高原创 ”。

这些SEO小功能不仅提高了网站页面原创的度数,还间接提升了网站的收录排名。您可以通过软件工具上的监控管理直接查看文章采集的发布状态,不再需要每天登录网站后台查看。目前博主亲测软件是免费的,可以直接下载使用!

一、什么是 网站 标签?

网站标签说明:网站内容的组织,使得网站的内容可以清晰划分,方便搜索引擎检索和分享,与其他用户体验。简单来说,网站标签就是用来对网站内容进行分类,方便检索。

现在做SEO优化,你越来越关注网站的可访问性和用户体验。你的网站速度够快,内容有价值,解决用户需求的能力有利于竞争,价值越高。毫无疑问,网站更具竞争力,而网站标签在网站效果的整体优化中起着非常重要的作用。

通过网站标签,用户和搜索引擎都可以了解网站的框架和内容,快速找到对应的信息。因此,一个网站的标签系统越完善,用户体验就越高,搜索引擎给出的评分也越高。

二、网站 标签在 SEO 优化中起什么作用?

1、有主题效果

网站 的每个标签都是从相关内容聚合而成的。一个标签往往就相当于一个小话题,话题页面的排名比一般页面要好,所以网站标签的优化也要花点心思。比如三大标签的写法,网页内容的布局等等。毕竟排名是网站综合影响的结果,细节上也要注意。

2、 赞成 收录 和 网站 的排名

网站的标签非常重要,它直接影响到我们网站的收录、排名和用户流量。首先,用户通过关键词搜索找到我们网站。这时候,清晰吸引人的描述标签(网站三大标签TDK)可以引导更多用户浏览。

而网站有大量的标签,也就是说它有大量的网站页面入口,标签也属于某种聚合的范畴。例如,同一篇文章文章可以对应很多标签,同一个标签也可能对应很多文章文章。在这种情况下,网站的内容将有利于蜘蛛爬取,增加收录的可能性,对网站的排名也有一定的影响。

3、提升用户体验

网站设置好的标签可以提升用户体验,比如清晰的导航标签,可以方便用户检索信息。如果提供有价值的内容,不仅可以给网站带来更多的收益,浏览量也可以增加网站用户的使用时间。

另外,用户体验越好网站,搜索引擎的友好度就越高,因为我们SEO优化的所有前提都必须与搜索引擎保持一致。所以,设置好网站标签,可以一石三鸟。

网站标签对网站 SEO优化有很多好处,所以我们必须谨慎设置自己的网站标签,下面我将与大家分享一些实用技巧。

网站 标签的作用和优化

三、如何善用网站标签达到优化效果?

1、网站TDK标签优化

title:一般设置为3-5关键词+品牌词/1,关键词取决于网站的定位,收录核心业务。

描述:主要是网站介绍的内容,标题中可以适当收录关键词,字数一般控制在80左右。正确填写网站的描述@>不仅可以提高网站的业务相关性,还可以提升网站关键词的匹配度,有利于网站关键词的排名。

关键字:设置关键词标签更多的是辅助功能,不会显示在搜索结果中。提炼时可以重复标题的内容。相对来说,它没有标题和描述那么重要,但按照规范填写肯定更好。

2、网站内容标签优化

网站内容标签优化包括常见的A标签、P标签、H标签等标签的优化。详情如下:

A标签的作用:就是我们常说的添加描述文字。通过添加到目标关键词 的内部链接作为描述文本,它指向其他网页。适当添加A标签可以让搜索引擎爬得更快,提高网站排名,增加用户体验。

P标签的作用:当搜索引擎蜘蛛抓取网页内容时,它使用P属性来识别每个段落和句子之间的语法所表达的意思,P标签的出现频率将决定搜索引擎对网站 内容质量的评价,所以我们根据内容表达的需要调整它的频率。

H标签的作用:H标签通常分为h1~h6标签,其中h1标签是一个权重很大的标签,每个站点只允许出现一次,所以我们通常把h1标签放在在 文章 的标题上,其他级别的标签可以相应的放置在字幕等位置,标志上也使用了 H1,具体定位见 网站。

3、ALT标签优化

ALT 标记被添加到 网站 图片。搜索引擎蜘蛛只能读取 HTML 代码、文本和数字内容。图片添加ALT标签相当于添加图片的描述信息。

四、nofollow 标签优化

合理使用nofollow可以集中网站的权重,但也要注意很多人会加nofollow到朋友链!很多人会因为太繁琐而放弃做这些细节。如果你这么轻易放弃,不建议你成为seoer。相反,如果你坚持去做,你会得到意想不到的结果。相信我,赶快行动吧!

看完这篇文章,如果觉得不错,不妨采集一下,或者发给需要的朋友同事。关注博主,每天为你展示各种SEO经验,打通你的二线任命和主管!

自动采集(大数据分析技术起来很容易,你知道吗?(一))

采集交流 • 优采云 发表了文章 • 0 个评论 • 124 次浏览 • 2022-02-12 14:01

自动采集自已需要的信息。或者个人成为集团或者方站,需要从本站下载什么文件,就自动推送到对应网站并且说明如果没有对应网站那么就会推送到,你首页的hi,或者是可见feed,

是否不能代购并被理解为盗版或侵权,要看版权方。

在上面搜索大数据可以找到数据分析的例子,

在这个地方有一点用,数据分析技术起来很容易,

1.做生意,数据和关键词2.经商之前必须知道什么做主,什么做次,做好了能卖多少钱。

可以,

android应用采集第三方的rss以及个人博客的图片-新闻数据源总体而言新闻获取这个技术是没有问题的第三方rss或博客的技术与相关数据源目前都不是特别成熟,数据源比较多,获取难度大,信息源比较少,比较难以分析,比较难以在后续优化上有什么突破。个人博客的技术相对单一,但实际上收集了不少有价值的内容。但个人博客和rss之间还是有一些差异的。

最近在看大数据与网站分析,在国内网站上没有涉及到。stackexchange上提到一个好问题-us/other/problems/what-does-the-methods-of-the-web-are-the-good-part-when-the-methods-of-improving-the-marketing-seo-service-and-what-does-the-methods-of-the-shopping-web/。 查看全部

自动采集(大数据分析技术起来很容易,你知道吗?(一))

自动采集自已需要的信息。或者个人成为集团或者方站,需要从本站下载什么文件,就自动推送到对应网站并且说明如果没有对应网站那么就会推送到,你首页的hi,或者是可见feed,

是否不能代购并被理解为盗版或侵权,要看版权方。

在上面搜索大数据可以找到数据分析的例子,

在这个地方有一点用,数据分析技术起来很容易,

1.做生意,数据和关键词2.经商之前必须知道什么做主,什么做次,做好了能卖多少钱。

可以,

android应用采集第三方的rss以及个人博客的图片-新闻数据源总体而言新闻获取这个技术是没有问题的第三方rss或博客的技术与相关数据源目前都不是特别成熟,数据源比较多,获取难度大,信息源比较少,比较难以分析,比较难以在后续优化上有什么突破。个人博客的技术相对单一,但实际上收集了不少有价值的内容。但个人博客和rss之间还是有一些差异的。

最近在看大数据与网站分析,在国内网站上没有涉及到。stackexchange上提到一个好问题-us/other/problems/what-does-the-methods-of-the-web-are-the-good-part-when-the-methods-of-improving-the-marketing-seo-service-and-what-does-the-methods-of-the-shopping-web/。

自动采集(Diddums这款小工具自带AlfredWorkflow可快速Diddums窗口)

采集交流 • 优采云 发表了文章 • 0 个评论 • 127 次浏览 • 2022-02-10 01:03

你玩过Pinboard吗?他的工具资源一样,非常丰富。我们推荐 Mac 端的 Diddums。您可以通过内置的 Alfred Workflow 快速调用 Diddums 窗口。请注意,里面的 URL、Title 和 Tags 不需要您手动输入。Diddums 会在浏览器中自动采集您当前页面的内容,Diddums 支持 Chrome 和 Safari 浏览器的自动采集。

在使用 Diddums 之前,您需要使用 Pinboard API Token 来验证您的帐户。

玩百科:

什么是插板?

Pinboard是一个独特的网络书签存储和管理在线服务网站,没有广告,没有花哨的UI和附加功能,所有的服务和工具都是围绕“书签”构建的,你可以使用周边的浏览器插件、桌面系统客户端或移动应用程序采集所有感兴趣的书签都存储在 Pinboard 中。

Pinboard 提供 Network 频道供用户浏览关注的好友刚刚添加的公共书签,Recent 和 Popular 频道浏览全站书签资源

Pinboard 提供了 3 种自动添加书签的方法:

1. 导入浏览器书签导出文件(支持三大浏览器)

2. 自动在 Delicious、Instapaper、Readability、Pocket 帐户中添加新书签

3. 为 Google Reader、Delicious、Diigo、Trunk.ly 引入书签导出文件

工具

Pinboard提供的工具非常实用,有开发者用,手机端浏览,通过,各种,书签设置隐私,别人看不到,

关于 Pinboard 注册

一个好的服务自然有相应的支付机制来衬托它的价值,Pinboard 也不例外。现在,您需要花费 10 美元才能享受 Pinboard(一次性费用),并且此注册费将在 Pinboard 上注册。会员人数越来越多,越来越多(够了……想用就尽快注册,不然以后会越来越贵)。

系统会自动将每个书签内容归档为快照,供用户永久采集。同时,用户还可以享受独有的全文搜索书签服务。第一年进入Pinboard的用户只需支付“25$减去注册费”的差价即可享受一年的书签归档服务。 查看全部

自动采集(Diddums这款小工具自带AlfredWorkflow可快速Diddums窗口)

你玩过Pinboard吗?他的工具资源一样,非常丰富。我们推荐 Mac 端的 Diddums。您可以通过内置的 Alfred Workflow 快速调用 Diddums 窗口。请注意,里面的 URL、Title 和 Tags 不需要您手动输入。Diddums 会在浏览器中自动采集您当前页面的内容,Diddums 支持 Chrome 和 Safari 浏览器的自动采集。

在使用 Diddums 之前,您需要使用 Pinboard API Token 来验证您的帐户。

玩百科:

什么是插板?

Pinboard是一个独特的网络书签存储和管理在线服务网站,没有广告,没有花哨的UI和附加功能,所有的服务和工具都是围绕“书签”构建的,你可以使用周边的浏览器插件、桌面系统客户端或移动应用程序采集所有感兴趣的书签都存储在 Pinboard 中。

Pinboard 提供 Network 频道供用户浏览关注的好友刚刚添加的公共书签,Recent 和 Popular 频道浏览全站书签资源

Pinboard 提供了 3 种自动添加书签的方法:

1. 导入浏览器书签导出文件(支持三大浏览器)

2. 自动在 Delicious、Instapaper、Readability、Pocket 帐户中添加新书签

3. 为 Google Reader、Delicious、Diigo、Trunk.ly 引入书签导出文件

工具

Pinboard提供的工具非常实用,有开发者用,手机端浏览,通过,各种,书签设置隐私,别人看不到,

关于 Pinboard 注册

一个好的服务自然有相应的支付机制来衬托它的价值,Pinboard 也不例外。现在,您需要花费 10 美元才能享受 Pinboard(一次性费用),并且此注册费将在 Pinboard 上注册。会员人数越来越多,越来越多(够了……想用就尽快注册,不然以后会越来越贵)。

系统会自动将每个书签内容归档为快照,供用户永久采集。同时,用户还可以享受独有的全文搜索书签服务。第一年进入Pinboard的用户只需支付“25$减去注册费”的差价即可享受一年的书签归档服务。

自动采集( YYCMS影视网源码自动采集数据一键搭建,原理是什么? )

采集交流 • 优采云 发表了文章 • 0 个评论 • 160 次浏览 • 2022-02-06 21:14

YYCMS影视网源码自动采集数据一键搭建,原理是什么?

)

宇宇cms-YYcms5.0新版影视网自动源代码采集数据-悦雅cms

YYcms视频网络自动源码采集数据一键建站,原理是采集视频链接+网络分析接口实现!

最近一直想搭建一个看视频的平台,找了半天找到了这个源码,分享给大家!

之前的视频制作平台有:YYcms和Applecms

苹果cms需要手动去采集数据,但是页面可以美化美观,网上也可以采集别人做的模板

YYcms是自动的采集数据,但是解析接口需要维护(一般一段时间后解析接口会失效,需要自己找维护)

我发的源码明显来自YYcms

原理是通过采集网络上的视频链接+解析接口来实现的

解析接口我这里就不提供了,自己去采集吧(F12扣别人)

构建教程:

仅限学习交流,研究研究源码,请勿商业化;也许“请去喝茶”

1.将压缩包上传到server/space根目录并解压

2.设置伪静态

3.运行:域/安装

运行这一步,如果/install显示404,表示权限未打开或伪静态设置错误

4.根据页面提示,自行创建数据库,然后填写账号密码。地址默认为 localhost。

5.构建完成后,进入后台管理页面,修改解析界面;

查看全部

自动采集(

YYCMS影视网源码自动采集数据一键搭建,原理是什么?

)

宇宇cms-YYcms5.0新版影视网自动源代码采集数据-悦雅cms

YYcms视频网络自动源码采集数据一键建站,原理是采集视频链接+网络分析接口实现!

最近一直想搭建一个看视频的平台,找了半天找到了这个源码,分享给大家!

之前的视频制作平台有:YYcms和Applecms

苹果cms需要手动去采集数据,但是页面可以美化美观,网上也可以采集别人做的模板

YYcms是自动的采集数据,但是解析接口需要维护(一般一段时间后解析接口会失效,需要自己找维护)

我发的源码明显来自YYcms

原理是通过采集网络上的视频链接+解析接口来实现的

解析接口我这里就不提供了,自己去采集吧(F12扣别人)

构建教程:

仅限学习交流,研究研究源码,请勿商业化;也许“请去喝茶”

1.将压缩包上传到server/space根目录并解压

2.设置伪静态

3.运行:域/安装

运行这一步,如果/install显示404,表示权限未打开或伪静态设置错误

4.根据页面提示,自行创建数据库,然后填写账号密码。地址默认为 localhost。

5.构建完成后,进入后台管理页面,修改解析界面;

自动采集(自动采集有skreal的缓存,服务器可以不用全部上线)

采集交流 • 优采云 发表了文章 • 0 个评论 • 119 次浏览 • 2022-01-29 10:05

自动采集。key有skreal的缓存。服务器可以不用全部上线,一台能起来就足够了,这样即使下线,实时数据也有,不影响其他用户。用户新登录会触发实时数据同步到服务器。

类似于相关规定中所说的使用basictransaction做事务所以每一笔采集实际的上线和卸载状态是存在一定区别的。

eclipse的transaction有缓存,但每次执行都不一样,

如果采用这种设计,每一步生成的代码和中间结果都在实时上传到服务器,程序不需要停服务,之后才进行下一步更新。这是设计上的考虑,上面@郭陶说的都很对,你可以试试看看是否可行。

是的,本人的项目用了自动化采集,计划是线上收到一次,后续也是同步的。这种采集方式用在服务器依赖性较高的项目里面比较合适。

题主所说的eclipsetransaction,其实是你写的代码,在没有卸载的时候会有第一次没有配置spring服务器资源的处理,这部分代码被调用后才到你的目标数据,其实就是说这部分其实是线程安全的,线上会有实时上传,

把采集前一步到配置文件中间的处理都当成配置文件处理吧,所有的结果有了对照,除非系统强制更新。

我最近也在看transaction,我看的是静态网页的采集。不过很多这种调用会有缓存的。 查看全部

自动采集(自动采集有skreal的缓存,服务器可以不用全部上线)

自动采集。key有skreal的缓存。服务器可以不用全部上线,一台能起来就足够了,这样即使下线,实时数据也有,不影响其他用户。用户新登录会触发实时数据同步到服务器。

类似于相关规定中所说的使用basictransaction做事务所以每一笔采集实际的上线和卸载状态是存在一定区别的。

eclipse的transaction有缓存,但每次执行都不一样,

如果采用这种设计,每一步生成的代码和中间结果都在实时上传到服务器,程序不需要停服务,之后才进行下一步更新。这是设计上的考虑,上面@郭陶说的都很对,你可以试试看看是否可行。

是的,本人的项目用了自动化采集,计划是线上收到一次,后续也是同步的。这种采集方式用在服务器依赖性较高的项目里面比较合适。

题主所说的eclipsetransaction,其实是你写的代码,在没有卸载的时候会有第一次没有配置spring服务器资源的处理,这部分代码被调用后才到你的目标数据,其实就是说这部分其实是线程安全的,线上会有实时上传,

把采集前一步到配置文件中间的处理都当成配置文件处理吧,所有的结果有了对照,除非系统强制更新。

我最近也在看transaction,我看的是静态网页的采集。不过很多这种调用会有缓存的。

自动采集(求个免费的小说建站源码,带ASP都可以(图))

采集交流 • 优采云 发表了文章 • 0 个评论 • 153 次浏览 • 2022-01-24 21:12

首页 > 资料下载 > 免费自动采集网站源码源码网站采集

2022-01-24 下载资料围观

简介 找一个免费的小说建站源码,有自动后台采集,PHP ASP 即可。推荐使用ptcms帮你搭建免费的PHP小说网站源码?带有自动 采集 的那个!谁能用我加100分! !现在小说系统加密了,推荐使用dedecms建站。全站高负载+静态dede的采集cms也很厉害,但是要慢慢写采集规则其实其他新奇系统可能没有dedecms 易于使用。您可以使用 dedecms 创建自己的小说站。回报绝对超乎你的想象。我下载了一个网站源代码,那个网站本身有几个自动的采集程序,我现在都放在自己的空间里了,怎么做这些网站采集源码中收到

求免费小说建站源码,带自动后台采集,PHP ASP即可。

建议使用ptcms免费帮你搭建

谁有免费的PHP小说网站源码?带有自动 采集 的那个!谁能用我加100分! !

现在小说系统加密了,推荐使用dedecms建站。全站高负载+静态dede的采集cms也很厉害,不过要慢慢写采集规则其实其他新奇系统可能没有dedecms易于使用。你可以用dedecms创建自己的小说站,奖励绝对超乎你的想象

我下载了一个网站源代码,那个网站本身有几个自动的采集程序,我现在放到自己的空间里,怎么获取这些

网站采集源代码应该有提示采集的超级工作。如果没有解释,那么你应该去另一个解释该方法的源代码。

百度网盘下载:

标签: 查看全部

自动采集(求个免费的小说建站源码,带ASP都可以(图))