小鬼快搜去广告版,漫画、小说一网打尽

网站优化 • 优采云 发表了文章 • 0 个评论 • 88 次浏览 • 2022-05-23 21:44

喜欢看小说、漫画的伙伴日常在网页端食用时看着满屏的弹窗广告心中一定一团怒火。即使选择客户端食用时很多APP上也免不了软件内嵌的广告,甚至以会员形式来收费去除广告。

小鬼快搜,很好的解决工具之一。

囊括了海量的免费优质资源,再加上聚合各大搜索引擎可全方面搜索想要的内容,配合软件自带的网页嗅探,净化网页去广告,捕获下载源,自动分集分章节等诸多贴心功能能够带来绝佳的浏览体验。

因为资源全是来源于网络搜索爬取所以也不用太考虑资源以及软件失效等问题,除了悲催到断网否则能一直用下去。目前有小说、漫画、TXT三个板块,效果还不错全部都是免费提供的。

如果有一天发现收费无法享用时,那一定是嗅探到的资源变成收费了,不是软件起的猫腻。

软件自身没有任何广告,非常的纯净!

软件介绍:

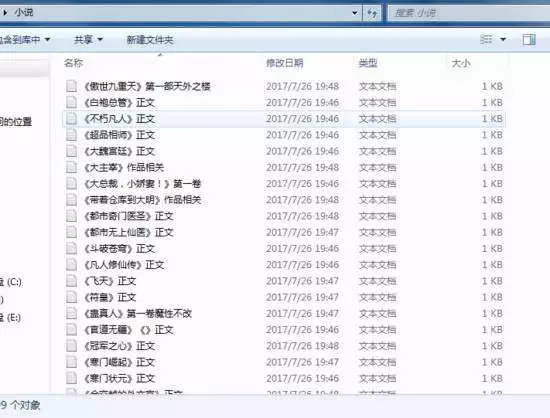

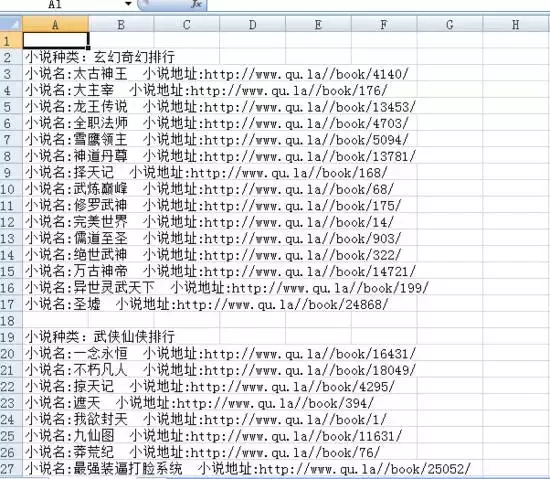

小说

小鬼快搜的小说版块和TXT版块一直让橘子疑惑:都是看书籍的功能为啥要分两个版块,而且两个版块搜索展现的内容都不一样。原来有一个搜索文学读物比较给力,另一个网络小说比较齐全。

如果没有搜索到想要的书籍可以试试换源、全网搜索,然后就会跳转到各大搜索引擎搜索,此时与大家用浏览器搜索内容基本一致,但是软件贴心的地方就来了。

能够一键嗅探是否有相关资源的网页,一键净化原网页的广告并自动转换为软件内阅读器上阅读,此时你会发现章节都为之整理好了。对于喜欢在网页看小说的小伙伴不妨试试这个功能确实挺赞的。

净化前后对比

漫画

漫画功能丝毫不含糊,老规矩搜索展现大量的网络内容,没找到依旧是全网搜索净化页面,转换到软件内的阅读器上阅读,再也不受各种横幅广告的影响。

在阅读时发现章节缺少或者体验不佳可以在底部点击换源,另外还可以直接离线下载至手机本地方便下次快速观看。无论是看小说还是追漫画,都可以加入收藏方便下次打开避免重新找资源的窘境。

净化前后对比

破解说明:

去除广告

说明:小鬼快搜将在今后更换服务器并迁移相关数据,待服务器稳定后旧版本可能就无法继续使用。不过伙伴们放心,如有变化,同步更新分享。

比较遗憾,小鬼快搜没有iOS版。唯一美中不足的就是旧版本中加入了影视板块,在此板中却给剔除了。

软件自身不存储任何资源,完全是依赖于网络搜索抓取,因此容易受一些网页中不安全因素影响,作为科学合理使用还是一款不可多得的应用。

往期精品软件

安装包:

公众号后台发送:424 查看全部

小鬼快搜去广告版,漫画、小说一网打尽

喜欢看小说、漫画的伙伴日常在网页端食用时看着满屏的弹窗广告心中一定一团怒火。即使选择客户端食用时很多APP上也免不了软件内嵌的广告,甚至以会员形式来收费去除广告。

小鬼快搜,很好的解决工具之一。

囊括了海量的免费优质资源,再加上聚合各大搜索引擎可全方面搜索想要的内容,配合软件自带的网页嗅探,净化网页去广告,捕获下载源,自动分集分章节等诸多贴心功能能够带来绝佳的浏览体验。

因为资源全是来源于网络搜索爬取所以也不用太考虑资源以及软件失效等问题,除了悲催到断网否则能一直用下去。目前有小说、漫画、TXT三个板块,效果还不错全部都是免费提供的。

如果有一天发现收费无法享用时,那一定是嗅探到的资源变成收费了,不是软件起的猫腻。

软件自身没有任何广告,非常的纯净!

软件介绍:

小说

小鬼快搜的小说版块和TXT版块一直让橘子疑惑:都是看书籍的功能为啥要分两个版块,而且两个版块搜索展现的内容都不一样。原来有一个搜索文学读物比较给力,另一个网络小说比较齐全。

如果没有搜索到想要的书籍可以试试换源、全网搜索,然后就会跳转到各大搜索引擎搜索,此时与大家用浏览器搜索内容基本一致,但是软件贴心的地方就来了。

能够一键嗅探是否有相关资源的网页,一键净化原网页的广告并自动转换为软件内阅读器上阅读,此时你会发现章节都为之整理好了。对于喜欢在网页看小说的小伙伴不妨试试这个功能确实挺赞的。

净化前后对比

漫画

漫画功能丝毫不含糊,老规矩搜索展现大量的网络内容,没找到依旧是全网搜索净化页面,转换到软件内的阅读器上阅读,再也不受各种横幅广告的影响。

在阅读时发现章节缺少或者体验不佳可以在底部点击换源,另外还可以直接离线下载至手机本地方便下次快速观看。无论是看小说还是追漫画,都可以加入收藏方便下次打开避免重新找资源的窘境。

净化前后对比

破解说明:

去除广告

说明:小鬼快搜将在今后更换服务器并迁移相关数据,待服务器稳定后旧版本可能就无法继续使用。不过伙伴们放心,如有变化,同步更新分享。

比较遗憾,小鬼快搜没有iOS版。唯一美中不足的就是旧版本中加入了影视板块,在此板中却给剔除了。

软件自身不存储任何资源,完全是依赖于网络搜索抓取,因此容易受一些网页中不安全因素影响,作为科学合理使用还是一款不可多得的应用。

往期精品软件

安装包:

公众号后台发送:424

网页小说抓取 ios(软件界面主界面任务管理系统设置+ePub制作)

网站优化 • 优采云 发表了文章 • 0 个评论 • 87 次浏览 • 2022-04-01 16:00

新颖的规则捕捉器是共享共享的,可以帮助用户分析相关代码,抓取目标网站的新颖资源,支持直接捕获,或者目标设置,在一定范围内筛选后捕获目标。针对性强,可以设置多个条件,让用户更快的找到自己想看的小说资源。

【软件特色】

自定义规则抓取,可以文章抓取大部分小说网,个别网站分类书籍详细分类,还支持多本抓取;

自带海量预测网站,不定义规则的用户可以直接套用,也可以抓取自己需要的小说;

自带源码查看器,提供链接分析、关键定位、标签分割等工具;

对于大型小说,任务暂存数据库后,可随意中断和恢复;

图书提供多种输出方式:章节文件、独立文本文件、压缩包、ePub电子书等;

支持任务导入,即从文本文件和带有章节页面链接的excel文档中导入任务进行抓取;

所有组件都支持提示信息,即光标停止后会显示相关提示,大部分操作都支持状态栏提示,使用更方便;

支持添加、修改、导入、导出、排序、删除预设网站;

【功能介绍】

本软件可以通过小说网站的html网页源码抓书,分析关键信息的规律,最终输出抓书(支持txt、ePub、zip格式输出)。

这个软件可以说好用也好难,比如简单的从网站抓书,直接从自带的100多个预设网站抓(需要浏览通过你可以用浏览器搜索你想下载的书,然后复制链接到入口网址),无需分析复杂的源码。对于逻辑思维能力强的用户,通过分析小说网站的源码,制定网站的抓包规则,基本可以应对大部分小说网站。

【工具特点】

ePub电子书制作分解工具,支持分章存储的书籍生成ePub文件,也可以将ePub文件分解成多章文本文件。

软件界面

主界面

任务管理

系统设置 + ePub 小部件

分析代码窗口

【更新日志】

修复已知问题并优化软件。 查看全部

网页小说抓取 ios(软件界面主界面任务管理系统设置+ePub制作)

新颖的规则捕捉器是共享共享的,可以帮助用户分析相关代码,抓取目标网站的新颖资源,支持直接捕获,或者目标设置,在一定范围内筛选后捕获目标。针对性强,可以设置多个条件,让用户更快的找到自己想看的小说资源。

【软件特色】

自定义规则抓取,可以文章抓取大部分小说网,个别网站分类书籍详细分类,还支持多本抓取;

自带海量预测网站,不定义规则的用户可以直接套用,也可以抓取自己需要的小说;

自带源码查看器,提供链接分析、关键定位、标签分割等工具;

对于大型小说,任务暂存数据库后,可随意中断和恢复;

图书提供多种输出方式:章节文件、独立文本文件、压缩包、ePub电子书等;

支持任务导入,即从文本文件和带有章节页面链接的excel文档中导入任务进行抓取;

所有组件都支持提示信息,即光标停止后会显示相关提示,大部分操作都支持状态栏提示,使用更方便;

支持添加、修改、导入、导出、排序、删除预设网站;

【功能介绍】

本软件可以通过小说网站的html网页源码抓书,分析关键信息的规律,最终输出抓书(支持txt、ePub、zip格式输出)。

这个软件可以说好用也好难,比如简单的从网站抓书,直接从自带的100多个预设网站抓(需要浏览通过你可以用浏览器搜索你想下载的书,然后复制链接到入口网址),无需分析复杂的源码。对于逻辑思维能力强的用户,通过分析小说网站的源码,制定网站的抓包规则,基本可以应对大部分小说网站。

【工具特点】

ePub电子书制作分解工具,支持分章存储的书籍生成ePub文件,也可以将ePub文件分解成多章文本文件。

软件界面

主界面

任务管理

系统设置 + ePub 小部件

分析代码窗口

【更新日志】

修复已知问题并优化软件。

网页小说抓取 ios( iOS14.2公测版beta1版描述文件在哪下载(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 112 次浏览 • 2022-03-29 14:20

iOS14.2公测版beta1版描述文件在哪下载(组图))

iOS14.2公测beta1描述文件下载地址 iOS14.2在哪里下载描述文件

9月22日,今天苹果正式发布了iOS14.2公测版的beta1版本,增加了一些小功能。很多朋友还不知道iOS14.2描述文件在哪里下载。下面就和大家分享一下吧。说明文件下载:iOS14/iPa

iOS13.6GM版本描述文件下载地址 iOS13.6GM版本描述文件在哪里下载

7月10日,苹果正式发布了iOS13.6GM版本,有小伙伴还不知道去哪里下载iOS13.6GM版本描述文件,跟大家分享一下iOS13.的6GM版本描述文件的下载地址。Apple 于 2020 年 7 月 10 日发布

iOS13.6Beta3开发者版本描述文件下载地址苹果ios13.6在哪里下载描述文件

苹果iOS13.6开发者预览版Beta3已经发布。该版本主要修复了一些bug,提升了性能。有的小伙伴还不知道去哪里下载iOS13.6开发者预览版Beta3的描述文件,下面为大家分解一下

iOS14.2公测版Beta3描述文件下载iOS14.2描述文件在哪里下载

2020年10月15日,今天苹果正式发布了iOS14.2公测Beta3版本,增加了一些小功能和表情,部分朋友还在寻找iOS14.2公测Beta3版本的描述文件,分享给大家。苹果在 iO

我怎样才能写出更好的 网站 描述?

网站的描述怎么写?首先说明他不会参与网站排名的计算,但是对于促进用户的刺激点击起到了很大的作用。如果 网站 描述写得好,很容易吸引用户的眼球并点击您的 网站。

16个如何写好应用描述的例子:不仅仅是把ASO做得好

应用描述很重要,很多人都知道,但是你有没有亲自比较和研究过其他人的应用是如何描述的?

如何提高 DSR 中婴儿描述的评分

在DSR动态评分越来越重要的今天,作为卖家,我们应该如何优化我们的产品描述,避免出错,提高评分呢?

iOS13.7开发版beta描述文件下载地址 iOS13.7开发版描述文件在哪里下载

2020 年 8 月 27 日,今天苹果再次推送 iOS13.7 的开发者预览 Beta 版,允许您选择加入 COVID-19 暴露通知系统并修复一些错误。下面给大家看分享这个iOS13.7开发者预览

iOS15描述文件下载地址 iOS15开发者测试版描述文件在哪里下载

苹果iOS15系列

iOS14beta4和iPadOS14描述文件下载地址自带详细安装教程

2020年8月5日,iOS14beta4正式推送更新。本次更新主要修复了一些bug,并没有特别大的更新内容。很多朋友还在找iOS14beta4的描述文件下载。让我和你分享这个。时代iOS14be

iOS9学习系列:打通iOS9的通用链接(UniversalLinks)

iOS9学习系列:打通iOS9的通用链接 2015-09-02 11:50 编辑:随玲 分类:iOS开发 来源:HOKO的博客04446iOS9通用链接:BreakingdowniOS9U

iOS14Beta5公测描述文件下载 iOS14Beta5描述文件在哪里下载

2020年8月20日,苹果推送iOS14公测版Beta5。这个版本有很多内容更新,其中最重要的就是修复了王者荣耀的登录和闪退bug。让我和你分享这个。第二次 iOS14 Public Beta Beta

网站如何优化如何设置描述?

描述是Head和整个网页SEO的第二个重要部分。虽然搜索引擎不将其设置为排名因素,但它可以引导搜索引擎找到他们需要的内容。那么,网站如何在优化中设置SEO中的描述(Description)呢?

网站写描述有什么意义?

今天笔者就来聊一聊网站描述的写法,帮助站长们了解如何写网站描述,既保证用户体验,又利于SEO。

元创:网站如何写出更好的描述

元创在推诊培训的时候,看到很多朋友网站的描述还是写错了。你可能遇到过他们。你要的信息是搜索引擎给你设置的描述不理想,所以抓取其他内容替换文章描述内容,今天元创就说描述如下 查看全部

网页小说抓取 ios(

iOS14.2公测版beta1版描述文件在哪下载(组图))

iOS14.2公测beta1描述文件下载地址 iOS14.2在哪里下载描述文件

9月22日,今天苹果正式发布了iOS14.2公测版的beta1版本,增加了一些小功能。很多朋友还不知道iOS14.2描述文件在哪里下载。下面就和大家分享一下吧。说明文件下载:iOS14/iPa

iOS13.6GM版本描述文件下载地址 iOS13.6GM版本描述文件在哪里下载

7月10日,苹果正式发布了iOS13.6GM版本,有小伙伴还不知道去哪里下载iOS13.6GM版本描述文件,跟大家分享一下iOS13.的6GM版本描述文件的下载地址。Apple 于 2020 年 7 月 10 日发布

iOS13.6Beta3开发者版本描述文件下载地址苹果ios13.6在哪里下载描述文件

苹果iOS13.6开发者预览版Beta3已经发布。该版本主要修复了一些bug,提升了性能。有的小伙伴还不知道去哪里下载iOS13.6开发者预览版Beta3的描述文件,下面为大家分解一下

iOS14.2公测版Beta3描述文件下载iOS14.2描述文件在哪里下载

2020年10月15日,今天苹果正式发布了iOS14.2公测Beta3版本,增加了一些小功能和表情,部分朋友还在寻找iOS14.2公测Beta3版本的描述文件,分享给大家。苹果在 iO

我怎样才能写出更好的 网站 描述?

网站的描述怎么写?首先说明他不会参与网站排名的计算,但是对于促进用户的刺激点击起到了很大的作用。如果 网站 描述写得好,很容易吸引用户的眼球并点击您的 网站。

16个如何写好应用描述的例子:不仅仅是把ASO做得好

应用描述很重要,很多人都知道,但是你有没有亲自比较和研究过其他人的应用是如何描述的?

如何提高 DSR 中婴儿描述的评分

在DSR动态评分越来越重要的今天,作为卖家,我们应该如何优化我们的产品描述,避免出错,提高评分呢?

iOS13.7开发版beta描述文件下载地址 iOS13.7开发版描述文件在哪里下载

2020 年 8 月 27 日,今天苹果再次推送 iOS13.7 的开发者预览 Beta 版,允许您选择加入 COVID-19 暴露通知系统并修复一些错误。下面给大家看分享这个iOS13.7开发者预览

iOS15描述文件下载地址 iOS15开发者测试版描述文件在哪里下载

苹果iOS15系列

iOS14beta4和iPadOS14描述文件下载地址自带详细安装教程

2020年8月5日,iOS14beta4正式推送更新。本次更新主要修复了一些bug,并没有特别大的更新内容。很多朋友还在找iOS14beta4的描述文件下载。让我和你分享这个。时代iOS14be

iOS9学习系列:打通iOS9的通用链接(UniversalLinks)

iOS9学习系列:打通iOS9的通用链接 2015-09-02 11:50 编辑:随玲 分类:iOS开发 来源:HOKO的博客04446iOS9通用链接:BreakingdowniOS9U

iOS14Beta5公测描述文件下载 iOS14Beta5描述文件在哪里下载

2020年8月20日,苹果推送iOS14公测版Beta5。这个版本有很多内容更新,其中最重要的就是修复了王者荣耀的登录和闪退bug。让我和你分享这个。第二次 iOS14 Public Beta Beta

网站如何优化如何设置描述?

描述是Head和整个网页SEO的第二个重要部分。虽然搜索引擎不将其设置为排名因素,但它可以引导搜索引擎找到他们需要的内容。那么,网站如何在优化中设置SEO中的描述(Description)呢?

网站写描述有什么意义?

今天笔者就来聊一聊网站描述的写法,帮助站长们了解如何写网站描述,既保证用户体验,又利于SEO。

元创:网站如何写出更好的描述

元创在推诊培训的时候,看到很多朋友网站的描述还是写错了。你可能遇到过他们。你要的信息是搜索引擎给你设置的描述不理想,所以抓取其他内容替换文章描述内容,今天元创就说描述如下

网页小说抓取 ios(怎么下手操作才能确保万无一失呢?是爱站技术频道)

网站优化 • 优采云 发表了文章 • 0 个评论 • 89 次浏览 • 2022-03-17 13:01

在IOS开发中,我们都会遇到需要获取和修改内容的情况。这个时候我们应该如何开始操作,才能保证万事大吉呢?本文是科技频道小编带来的IOS开发中如何获取网页内容。希望对你的学习有所帮助。

stringByEvaluatingJavaScriptFromString

使用 stringByEvaluatingJavaScriptFromString 方法,需要在 UIWebView 中的页面加载后调用。我们在界面上拖放一个 UIWebView 控件。在Load中将google mobile加载到这个控件中,代码如下:

- (void)viewDidLoad

{

[super viewDidLoad];

webview.backgroundColor = [UIColor clearColor];

webview.scalesPageToFit =YES;

webview.delegate =self;

NSURL *url =[[NSURL alloc] initWithString:@"http://www.google.com.hk/m%3Fg ... ot%3B];

NSURLRequest *request = [[NSURLRequest alloc] initWithURL:url];

[webview loadRequest:request];

}

我们可以在 webViewDidFinishLoad 方法中通过 javascript 操作界面元素。

1、获取当前页面的url。

- (void)webViewDidFinishLoad:(UIWebView *)webView {

NSString *currentURL = [webView stringByEvaluatingJavaScriptFromString:@"document.location.href"];

2、获取页面标题:

NSString *title = [webview stringByEvaluatingJavaScriptFromString:@"document.title"];

3、修改界面元素的值。

NSString *js_result = [webView stringByEvaluatingJavaScriptFromString:@"document.getElementsByName('q')[0].value='朱祁林';"];

4、表单提交:

NSString *js_result2 = [webView stringByEvaluatingJavaScriptFromString:@"document.forms[0].submit(); "];

5、获取所有html

6、从网页中获取一个值

NSString *htmlNum = @"document.getElementById('title').innerText";

NSString *numHtmlInfo = [webView stringByEvaluatingJavaScriptFromString:htmlNum];

7、插入js代码

我们可以将上面的函数封装成一个js函数,并将这个函数插入到页面中执行。代码如下:

if ([title compare: @"Google"]==NSOrderedSame ) {

[webView stringByEvaluatingJavaScriptFromString:@"var script = document.createElement_x('script');"

"script.type = 'text/javascript';"

"script.text = "function myFunction() { "

"var field = document.getElementsByName('q')[0];"

"field.value='朱祁林';"

"document.forms[0].submit();"

"}";"

"document.getElementsByTagName_r('head')[0].appendChild(script);"];

[webView stringByEvaluatingJavaScriptFromString:@"myFunction();"];

}

看上面的代码:

一种。首先通过js创建一个script标签,类型为'text/javascript'。

湾。然后在这个标签中插入一个字符串,这个字符串就是一个函数:myFunction,这个函数实现了google自动搜索关键词的功能。

C。然后使用 stringByEvaluatingJavaScriptFromString 执行 myFunction 函数。

以上就是技术频道小编为大家介绍的IOS开发中如何获取网页内容。我希望它对你有帮助。非常感谢您的支持! 查看全部

网页小说抓取 ios(怎么下手操作才能确保万无一失呢?是爱站技术频道)

在IOS开发中,我们都会遇到需要获取和修改内容的情况。这个时候我们应该如何开始操作,才能保证万事大吉呢?本文是科技频道小编带来的IOS开发中如何获取网页内容。希望对你的学习有所帮助。

stringByEvaluatingJavaScriptFromString

使用 stringByEvaluatingJavaScriptFromString 方法,需要在 UIWebView 中的页面加载后调用。我们在界面上拖放一个 UIWebView 控件。在Load中将google mobile加载到这个控件中,代码如下:

- (void)viewDidLoad

{

[super viewDidLoad];

webview.backgroundColor = [UIColor clearColor];

webview.scalesPageToFit =YES;

webview.delegate =self;

NSURL *url =[[NSURL alloc] initWithString:@"http://www.google.com.hk/m%3Fg ... ot%3B];

NSURLRequest *request = [[NSURLRequest alloc] initWithURL:url];

[webview loadRequest:request];

}

我们可以在 webViewDidFinishLoad 方法中通过 javascript 操作界面元素。

1、获取当前页面的url。

- (void)webViewDidFinishLoad:(UIWebView *)webView {

NSString *currentURL = [webView stringByEvaluatingJavaScriptFromString:@"document.location.href"];

2、获取页面标题:

NSString *title = [webview stringByEvaluatingJavaScriptFromString:@"document.title"];

3、修改界面元素的值。

NSString *js_result = [webView stringByEvaluatingJavaScriptFromString:@"document.getElementsByName('q')[0].value='朱祁林';"];

4、表单提交:

NSString *js_result2 = [webView stringByEvaluatingJavaScriptFromString:@"document.forms[0].submit(); "];

5、获取所有html

6、从网页中获取一个值

NSString *htmlNum = @"document.getElementById('title').innerText";

NSString *numHtmlInfo = [webView stringByEvaluatingJavaScriptFromString:htmlNum];

7、插入js代码

我们可以将上面的函数封装成一个js函数,并将这个函数插入到页面中执行。代码如下:

if ([title compare: @"Google"]==NSOrderedSame ) {

[webView stringByEvaluatingJavaScriptFromString:@"var script = document.createElement_x('script');"

"script.type = 'text/javascript';"

"script.text = "function myFunction() { "

"var field = document.getElementsByName('q')[0];"

"field.value='朱祁林';"

"document.forms[0].submit();"

"}";"

"document.getElementsByTagName_r('head')[0].appendChild(script);"];

[webView stringByEvaluatingJavaScriptFromString:@"myFunction();"];

}

看上面的代码:

一种。首先通过js创建一个script标签,类型为'text/javascript'。

湾。然后在这个标签中插入一个字符串,这个字符串就是一个函数:myFunction,这个函数实现了google自动搜索关键词的功能。

C。然后使用 stringByEvaluatingJavaScriptFromString 执行 myFunction 函数。

以上就是技术频道小编为大家介绍的IOS开发中如何获取网页内容。我希望它对你有帮助。非常感谢您的支持!

网页小说抓取 ios(5.现代化设计的友善介面6.支援macOS作业系统FDM下载器)

网站优化 • 优采云 发表了文章 • 0 个评论 • 117 次浏览 • 2022-02-27 19:13

5.现代设计的友好界面

6.支持macOS操作系统

苹果FDM下载器介绍

Mac版软件支持多线程下载,支持定时任务下载,支持以目录列表查看和检索站点内容,支持下载网页内容、图片和文件,支持抓取网页链接,支持下载整个网站的内容(可以设置下载子目录的深度),理论上可以下载1000层以上的子目录网页和图片。

免费下载管理器支持抓取网页样式(保存为CSS内容),支持多种格式的网页抓取,包括:html、shtm、shtml、phtml、dhtml、php、hta、htc、cgi、asp、htm等。也可以自己设置格式,可以用“站点浏览器”在线查看目标网站子目录下的内容,支持三种下载通讯方式,支持断点续传,显示服务器是否支持续传您可以设置是否重新下载或覆盖。免费下载管理器是一款功能强大的下载工具,支持多线程拆分下载。

FDM下载器苹果版亮点

1. macOS 的免费下载管理器还允许您调整带宽使用、组织下载、控制种子优先级以及有效地下载大型和可恢复文件。

2.FDM 可以将您的所有下载速度提高 10 倍,还可以处理各种流行格式的视频资产,从 Web 浏览器拖放 URL,并同时下载多个文件。

3.我们的 fdm 网络下载管理器还兼容 Google Chrome、Mozilla Firefox、Microsoft Edge、Internet Explorer 和 Safari 等浏览器。 查看全部

网页小说抓取 ios(5.现代化设计的友善介面6.支援macOS作业系统FDM下载器)

5.现代设计的友好界面

6.支持macOS操作系统

苹果FDM下载器介绍

Mac版软件支持多线程下载,支持定时任务下载,支持以目录列表查看和检索站点内容,支持下载网页内容、图片和文件,支持抓取网页链接,支持下载整个网站的内容(可以设置下载子目录的深度),理论上可以下载1000层以上的子目录网页和图片。

免费下载管理器支持抓取网页样式(保存为CSS内容),支持多种格式的网页抓取,包括:html、shtm、shtml、phtml、dhtml、php、hta、htc、cgi、asp、htm等。也可以自己设置格式,可以用“站点浏览器”在线查看目标网站子目录下的内容,支持三种下载通讯方式,支持断点续传,显示服务器是否支持续传您可以设置是否重新下载或覆盖。免费下载管理器是一款功能强大的下载工具,支持多线程拆分下载。

FDM下载器苹果版亮点

1. macOS 的免费下载管理器还允许您调整带宽使用、组织下载、控制种子优先级以及有效地下载大型和可恢复文件。

2.FDM 可以将您的所有下载速度提高 10 倍,还可以处理各种流行格式的视频资产,从 Web 浏览器拖放 URL,并同时下载多个文件。

3.我们的 fdm 网络下载管理器还兼容 Google Chrome、Mozilla Firefox、Microsoft Edge、Internet Explorer 和 Safari 等浏览器。

网页小说抓取 ios(一下python使用过程中可能遇到的小问题和爬取的简单思路)

网站优化 • 优采云 发表了文章 • 0 个评论 • 101 次浏览 • 2022-02-13 05:17

这次主要给大家分享一下python爬虫在使用过程中可能遇到的一些爬虫的小问题和简单的思路。

我自己不是程序员,python相关的内容也是自学的。如果您发现我的代码中有可以优化和改进的地方,请不吝赐教。即使是像我这样的普通新手,如果你找到更好的解决方案,也请分享,大家一起进步。

任务目标:

从 Tadu 文学的 网站 中获取小说并将其保存为 TXT 格式。

简单级应用,输入小说目录的URL,爬取所有内容。

程序流程图:

1、爬取小说目录网页信息

2、获取所有章节名称和链接

3、依次进入每一章的页面,抓取内容依次写入同一个txt文件

梦欣采用的技术:

1、urllib.request库-----操作url

2、循环中断,继续

3、时间库-------系统暂停

4、lxml库--------获取html代码中的指定内容

5、string.replace() 方法--------修改替换字符串的内容

6、用open()方法来操作文件

都是简单的技术,思路也比较简单,给大家做个参考。

首先是章节内容。通过DevTools可以发现文章内容在一个div中,整个html代码都有相关注释

那么复制xpath之后,任务就变成了获取[ //*[@id="partContent"] ]下所有P标签的内容,形成一个完整的章节内容。

我们开始简单,获取网页的内容,然后找到所有的章节文字,打印出来看看效果。

[Python] 纯文本查看

# -*- coding: utf-8 -*-

"""

Created on Wed Apr 7 15:32:39 2021

@author: roshinntou

"""

from lxml import etree

import urllib.request

import time

mainUrl = 'http://www.tadu.com'

def get_html_code(url):

max_count = 6

htmlcode = ''

for i in range(max_count):

print('No.'+str(i)+' start load:' + url)

try:

req_one = urllib.request.Request(url)

req_one.add_header('User-Agent', 'Mozilla/6.0')

res_one = urllib.request.urlopen(req_one, timeout=60)

htmlcode = res_one.read().decode('utf-8')

res_one.close()

break

except:

if i < max_count:

continue

else:

print('多次重复读取网页信息失败')

time.sleep(1)

return htmlcode

if __name__ == '__main__':

code = get_html_code('http://www.tadu.com/book/725327/86240835/')

html = etree.HTML(code)

text = html.xpath('//*[@id="partContent"]/p')

for i in text:

print(i.text)

这里,urllib.request 从获取html代码的过程中提取了一个方法。我将核心代码放入 for 循环并添加 try/catch 模块。如果一切正常,break 结束当前循环。如果报错,判断重复了多少次。,在指定次数内,使用 continue 重复执行核心代码,如果超过指定次数,会提示错误。(友情提示:由于网络波动或其他原因,爬取网页代码经常会超时,如果不添加循环方式,要么爬虫程序停止,要么爬取不到这部分的内容,影响最终结果.)

然后是内容处理。通过xpath,我们得到partContent div下的所有p标签,然后通过for循环打印出每个p标签的text文本。

但是执行的结果是:

读取html代码的模块不报错重复执行,只执行一次就结束。整个结果没有错误,证明至少所有的步骤都执行了,包括for循环,没有错误。没有超出下标等错误,也没有结果。for循环应该执行0次,没有得到P标签。

然后我们直接打印得到的html代码看看是怎么回事

结果发现:

如您所见,DIV 都找到了,但里面没有 文章 内容(红框位置)。所以没有错误,也没有执行结果。

然后它应该稍后动态加载。

刷新页面以查看网络内部的内容

然后我发现这个脚本有我们需要的

乱码需要重新编码为utf-8格式,回调是js的回调,所以网页代码中一定要有相关链接。我们打开网页的源码,搜索一下以“1462b”开头的东西看看:

可以看到这个输入的ID叫做bookPartResourceUrl,值里面的内容就是刚才的链接。那么我们在文章页面中获取这个链接的url地址,然后再次获取这个url地址的结果。主要方法的代码是:

[Python] 纯文本查看

if __name__ == '__main__':

code = get_html_code('http://www.tadu.com/book/725327/86240835/')

html = etree.HTML(code)

input_info = html.xpath('//*[@id="bookPartResourceUrl"]')[0].get('value')

code = get_html_code(input_info)

print(code)

第一步是获取这个页面的信息,然后找到input元素,获取它的value属性,得到一个url链接,然后再次读取这个链接的信息,结果是:

可以看到,两次浏览网页后,得到了文章的内容。每行内容都在一个 P 标签内。

此时,您可以通过多种方式使用它:

1、可以直接保存收录P标签的HTML代码,然后在网站中使用。

2、在保存txt的情况下,可以使用split的方式来'

'将这个内容截取成一个数组供目标使用,代码如下:

[Python] 纯文本查看

string.split('

')

3、我直接用replace方法,把'

' 替换为 '\n' 并且之前和之后的内容是固定的。直接截取string[22:-7]获取全部内容,然后直接写入txt文件即可。无需循环输入每个句子,性能消耗比较小

写法也很简单:

[Python] 纯文本查看

with open('网游:每十小时创造一个BUG.txt','a',encoding='utf-8') as file:

file.write('\n'+title+'\n')

file.write(text+'\n')

print('保存成功!')

使用with open的a模式,可以获取文件名作为参数传入,然后标题和内容换行,就可以连续写入同一个文件。现在主流的手机小说软件都是txt的,有多个切换进口不好。不要将每一章保存在单独的文件中。

到目前为止,我们已经能够根据章节 URL 获取章节的文本内容。接下来,我们需要一次性获取所有章节的标题和网址,然后依次读取所有章节并保存到一个txt文件中

先看目录结构:

它也是一个很简单的结构,每一章对应一个a标签。xpath 是 //*[@id="content"]/div[3]/div[2]/a

所以我们获取章节并进一步获取 文章 内容的方法应该是:

[Python] 纯文本查看

def get_all_url(url):

code = get_html_code(url)

print('get etree')

html = etree.HTML(code)

urlList = html.xpath('//*[@id="content"]/div[3]/div[2]/a')

for i in urlList:

title = i.text

title = title.replace(" ","").replace("\r\n","").replace(" ","").replace("\r","").replace("\n","")

url = i.get('href').replace(" ","").replace("\r\n","").replace(" ","").replace("\r","").replace("\n","")

print('title:'+title)

print('url:'+mainUrl+url)

get_text_by_url(mainUrl+url,title)

因为章节名前后有空格和换行符,所以我全部替换了。获取纯文本信息。

for循环就是将每一章的标题和URL传递给我们刚才做的保存内容的方法。

最后:

完整的代码是:

[Python] 纯文本查看

# -*- coding: utf-8 -*-

"""

Created on Thu Apr 8 11:48:39 2021

@author: roshinntou

"""

from lxml import etree

import urllib.request

import time

mainUrl = 'http://www.tadu.com'

def get_html_code(url):

max_count = 6

htmlcode = ''

for i in range(max_count):

print('No.'+str(i)+' start load:' + url)

try:

req_one = urllib.request.Request(url)

req_one.add_header('User-Agent', 'Mozilla/6.0')

res_one = urllib.request.urlopen(req_one, timeout=60)

htmlcode = res_one.read().decode('utf-8')

res_one.close()

break

except:

if i < max_count:

continue

else:

print('多次重复读取网页信息失败')

time.sleep(1)

return htmlcode

def get_all_url(url):

code = get_html_code(url)

print('get etree')

html = etree.HTML(code)

urlList = html.xpath('//*[@id="content"]/div[3]/div[2]/a')

for i in urlList:

title = i.text

title = title.replace(" ","").replace("\r\n","").replace(" ","").replace("\r","").replace("\n","")

url = i.get('href').replace(" ","").replace("\r\n","").replace(" ","").replace("\r","").replace("\n","")

print('title:'+title)

print('url:'+mainUrl+url)

get_text_by_url(mainUrl+url,title)

def get_text_by_url(url,title):

code = get_html_code(url)

html = etree.HTML(code)

input_info = html.xpath('//*[@id="bookPartResourceUrl"]')[0].get('value')

print(input_info)

code = get_html_code(input_info)

#text = code[22:-7].split('

')

text = code[22:-7].replace('

', '\n')

with open('网游:每十小时创造一个BUG.txt','a',encoding='utf-8') as file:

file.write('\n'+title+'\n')

file.write(text+'\n')

print('保存成功!')

if __name__ == '__main__':

get_all_url('http://www.tadu.com/book/catalogue/743142')

#get_text_by_url('http://www.tadu.com/book/749916/91083959/','title')

每次执行时将小说的目录URL复制到get_all_url方法的参数中,然后在上面用open改文件名。

至此,我们通过目录URL成功获取了小说的所有信息。

如果Ta阅读被抓得太快,他将被禁止。请注意。

程序还有很大的改进空间:

1、输入书名,自动搜索下载功能比较简单,搜索到的小说链接就是一般页面链接

例如:这是一般的页面链接,但目录链接是固定的。在书和后面的id号之间加上目录,也就是拿到链接后可以自己拼接。

有网站这个搜索,参数隐藏在url中。直接搜索显示默认 url:

其实还是有投稿的

然后测试接口:

发现参数是参数

这样就可以直接查询和获取内容了。

2、多进程爬取。当前的代码需要很长时间才能下载一两千章的小说。您可以一起爬升多个进程。更简单的方法是单独下载它们,然后再将它们拼接在一起。或者使用协程处理。 查看全部

网页小说抓取 ios(一下python使用过程中可能遇到的小问题和爬取的简单思路)

这次主要给大家分享一下python爬虫在使用过程中可能遇到的一些爬虫的小问题和简单的思路。

我自己不是程序员,python相关的内容也是自学的。如果您发现我的代码中有可以优化和改进的地方,请不吝赐教。即使是像我这样的普通新手,如果你找到更好的解决方案,也请分享,大家一起进步。

任务目标:

从 Tadu 文学的 网站 中获取小说并将其保存为 TXT 格式。

简单级应用,输入小说目录的URL,爬取所有内容。

程序流程图:

1、爬取小说目录网页信息

2、获取所有章节名称和链接

3、依次进入每一章的页面,抓取内容依次写入同一个txt文件

梦欣采用的技术:

1、urllib.request库-----操作url

2、循环中断,继续

3、时间库-------系统暂停

4、lxml库--------获取html代码中的指定内容

5、string.replace() 方法--------修改替换字符串的内容

6、用open()方法来操作文件

都是简单的技术,思路也比较简单,给大家做个参考。

首先是章节内容。通过DevTools可以发现文章内容在一个div中,整个html代码都有相关注释

那么复制xpath之后,任务就变成了获取[ //*[@id="partContent"] ]下所有P标签的内容,形成一个完整的章节内容。

我们开始简单,获取网页的内容,然后找到所有的章节文字,打印出来看看效果。

[Python] 纯文本查看

# -*- coding: utf-8 -*-

"""

Created on Wed Apr 7 15:32:39 2021

@author: roshinntou

"""

from lxml import etree

import urllib.request

import time

mainUrl = 'http://www.tadu.com'

def get_html_code(url):

max_count = 6

htmlcode = ''

for i in range(max_count):

print('No.'+str(i)+' start load:' + url)

try:

req_one = urllib.request.Request(url)

req_one.add_header('User-Agent', 'Mozilla/6.0')

res_one = urllib.request.urlopen(req_one, timeout=60)

htmlcode = res_one.read().decode('utf-8')

res_one.close()

break

except:

if i < max_count:

continue

else:

print('多次重复读取网页信息失败')

time.sleep(1)

return htmlcode

if __name__ == '__main__':

code = get_html_code('http://www.tadu.com/book/725327/86240835/')

html = etree.HTML(code)

text = html.xpath('//*[@id="partContent"]/p')

for i in text:

print(i.text)

这里,urllib.request 从获取html代码的过程中提取了一个方法。我将核心代码放入 for 循环并添加 try/catch 模块。如果一切正常,break 结束当前循环。如果报错,判断重复了多少次。,在指定次数内,使用 continue 重复执行核心代码,如果超过指定次数,会提示错误。(友情提示:由于网络波动或其他原因,爬取网页代码经常会超时,如果不添加循环方式,要么爬虫程序停止,要么爬取不到这部分的内容,影响最终结果.)

然后是内容处理。通过xpath,我们得到partContent div下的所有p标签,然后通过for循环打印出每个p标签的text文本。

但是执行的结果是:

读取html代码的模块不报错重复执行,只执行一次就结束。整个结果没有错误,证明至少所有的步骤都执行了,包括for循环,没有错误。没有超出下标等错误,也没有结果。for循环应该执行0次,没有得到P标签。

然后我们直接打印得到的html代码看看是怎么回事

结果发现:

如您所见,DIV 都找到了,但里面没有 文章 内容(红框位置)。所以没有错误,也没有执行结果。

然后它应该稍后动态加载。

刷新页面以查看网络内部的内容

然后我发现这个脚本有我们需要的

乱码需要重新编码为utf-8格式,回调是js的回调,所以网页代码中一定要有相关链接。我们打开网页的源码,搜索一下以“1462b”开头的东西看看:

可以看到这个输入的ID叫做bookPartResourceUrl,值里面的内容就是刚才的链接。那么我们在文章页面中获取这个链接的url地址,然后再次获取这个url地址的结果。主要方法的代码是:

[Python] 纯文本查看

if __name__ == '__main__':

code = get_html_code('http://www.tadu.com/book/725327/86240835/')

html = etree.HTML(code)

input_info = html.xpath('//*[@id="bookPartResourceUrl"]')[0].get('value')

code = get_html_code(input_info)

print(code)

第一步是获取这个页面的信息,然后找到input元素,获取它的value属性,得到一个url链接,然后再次读取这个链接的信息,结果是:

可以看到,两次浏览网页后,得到了文章的内容。每行内容都在一个 P 标签内。

此时,您可以通过多种方式使用它:

1、可以直接保存收录P标签的HTML代码,然后在网站中使用。

2、在保存txt的情况下,可以使用split的方式来'

'将这个内容截取成一个数组供目标使用,代码如下:

[Python] 纯文本查看

string.split('

')

3、我直接用replace方法,把'

' 替换为 '\n' 并且之前和之后的内容是固定的。直接截取string[22:-7]获取全部内容,然后直接写入txt文件即可。无需循环输入每个句子,性能消耗比较小

写法也很简单:

[Python] 纯文本查看

with open('网游:每十小时创造一个BUG.txt','a',encoding='utf-8') as file:

file.write('\n'+title+'\n')

file.write(text+'\n')

print('保存成功!')

使用with open的a模式,可以获取文件名作为参数传入,然后标题和内容换行,就可以连续写入同一个文件。现在主流的手机小说软件都是txt的,有多个切换进口不好。不要将每一章保存在单独的文件中。

到目前为止,我们已经能够根据章节 URL 获取章节的文本内容。接下来,我们需要一次性获取所有章节的标题和网址,然后依次读取所有章节并保存到一个txt文件中

先看目录结构:

它也是一个很简单的结构,每一章对应一个a标签。xpath 是 //*[@id="content"]/div[3]/div[2]/a

所以我们获取章节并进一步获取 文章 内容的方法应该是:

[Python] 纯文本查看

def get_all_url(url):

code = get_html_code(url)

print('get etree')

html = etree.HTML(code)

urlList = html.xpath('//*[@id="content"]/div[3]/div[2]/a')

for i in urlList:

title = i.text

title = title.replace(" ","").replace("\r\n","").replace(" ","").replace("\r","").replace("\n","")

url = i.get('href').replace(" ","").replace("\r\n","").replace(" ","").replace("\r","").replace("\n","")

print('title:'+title)

print('url:'+mainUrl+url)

get_text_by_url(mainUrl+url,title)

因为章节名前后有空格和换行符,所以我全部替换了。获取纯文本信息。

for循环就是将每一章的标题和URL传递给我们刚才做的保存内容的方法。

最后:

完整的代码是:

[Python] 纯文本查看

# -*- coding: utf-8 -*-

"""

Created on Thu Apr 8 11:48:39 2021

@author: roshinntou

"""

from lxml import etree

import urllib.request

import time

mainUrl = 'http://www.tadu.com'

def get_html_code(url):

max_count = 6

htmlcode = ''

for i in range(max_count):

print('No.'+str(i)+' start load:' + url)

try:

req_one = urllib.request.Request(url)

req_one.add_header('User-Agent', 'Mozilla/6.0')

res_one = urllib.request.urlopen(req_one, timeout=60)

htmlcode = res_one.read().decode('utf-8')

res_one.close()

break

except:

if i < max_count:

continue

else:

print('多次重复读取网页信息失败')

time.sleep(1)

return htmlcode

def get_all_url(url):

code = get_html_code(url)

print('get etree')

html = etree.HTML(code)

urlList = html.xpath('//*[@id="content"]/div[3]/div[2]/a')

for i in urlList:

title = i.text

title = title.replace(" ","").replace("\r\n","").replace(" ","").replace("\r","").replace("\n","")

url = i.get('href').replace(" ","").replace("\r\n","").replace(" ","").replace("\r","").replace("\n","")

print('title:'+title)

print('url:'+mainUrl+url)

get_text_by_url(mainUrl+url,title)

def get_text_by_url(url,title):

code = get_html_code(url)

html = etree.HTML(code)

input_info = html.xpath('//*[@id="bookPartResourceUrl"]')[0].get('value')

print(input_info)

code = get_html_code(input_info)

#text = code[22:-7].split('

')

text = code[22:-7].replace('

', '\n')

with open('网游:每十小时创造一个BUG.txt','a',encoding='utf-8') as file:

file.write('\n'+title+'\n')

file.write(text+'\n')

print('保存成功!')

if __name__ == '__main__':

get_all_url('http://www.tadu.com/book/catalogue/743142')

#get_text_by_url('http://www.tadu.com/book/749916/91083959/','title')

每次执行时将小说的目录URL复制到get_all_url方法的参数中,然后在上面用open改文件名。

至此,我们通过目录URL成功获取了小说的所有信息。

如果Ta阅读被抓得太快,他将被禁止。请注意。

程序还有很大的改进空间:

1、输入书名,自动搜索下载功能比较简单,搜索到的小说链接就是一般页面链接

例如:这是一般的页面链接,但目录链接是固定的。在书和后面的id号之间加上目录,也就是拿到链接后可以自己拼接。

有网站这个搜索,参数隐藏在url中。直接搜索显示默认 url:

其实还是有投稿的

然后测试接口:

发现参数是参数

这样就可以直接查询和获取内容了。

2、多进程爬取。当前的代码需要很长时间才能下载一两千章的小说。您可以一起爬升多个进程。更简单的方法是单独下载它们,然后再将它们拼接在一起。或者使用协程处理。

网页小说抓取 ios( Python3爬取新闻网站新闻列表到这里稍微复杂点怎么办)

网站优化 • 优采云 发表了文章 • 0 个评论 • 102 次浏览 • 2022-02-06 17:08

Python3爬取新闻网站新闻列表到这里稍微复杂点怎么办)

# 简单的网络爬虫

from urllib import request

import chardet

response = request.urlopen("http://www.jianshu.com/")

html = response.read()

charset = chardet.detect(html)# {'language': '', 'encoding': 'utf-8', 'confidence': 0.99}

html = html.decode(str(charset["encoding"])) # 解码

print(html)

复制代码

由于抓到的html文档比较长,这里简单贴个帖子给大家看看。

..........后面省略一大堆

复制代码

这是Python3爬虫的简单介绍,是不是很简单,建议你敲几遍

三、Python3抓取网页中的图片并将图片保存到本地文件夹

目标

import re

import urllib.request

#爬取网页html

def getHtml(url):

page = urllib.request.urlopen(url)

html = page.read()

return html

html = getHtml("http://tieba.baidu.com/p/3205263090")

html = html.decode('UTF-8')

#获取图片链接的方法

def getImg(html):

# 利用正则表达式匹配网页里的图片地址

reg = r'src="([.*\S]*\.jpg)" pic_ext="jpeg"'

imgre=re.compile(reg)

imglist=re.findall(imgre,html)

return imglist

imgList=getImg(html)

imgCount=0

#for把获取到的图片都下载到本地pic文件夹里,保存之前先在本地建一个pic文件夹

for imgPath in imgList:

f=open("../pic/"+str(imgCount)+".jpg",'wb')

f.write((urllib.request.urlopen(imgPath)).read())

f.close()

imgCount+=1

print("全部抓取完成")

复制代码

迫不及待想看看我爬过哪些美图

爬到 24 个女孩的照片是如此容易。是不是很简单。

四、Python3爬取新闻网站新闻列表

这里有点复杂,所以我会向你解释。

分析上图中我们要抓取的信息然后放到div中的a标签和img标签中,那么我们思考的是如何获取这些信息

这里会用到我们导入的BeautifulSoup4库,关键代码在这里

# 使用剖析器为html.parser

soup = BeautifulSoup(html, 'html.parser')

# 获取到每一个class=hot-article-img的a节点

allList = soup.select('.hot-article-img')

复制代码

上面代码得到的allList就是我们要获取的新闻列表,如下

[

,

,

,

,

,

,

,

,

,

,

]

复制代码

这里的数据是抓到的,但是太乱了,还有很多我们不想要的东西。让我们通过遍历提取我们的有效信息。

#遍历列表,获取有效信息

for news in allList:

aaa = news.select('a')

# 只选择长度大于0的结果

if len(aaa) > 0:

# 文章链接

try:#如果抛出异常就代表为空

href = url + aaa[0]['href']

except Exception:

href=''

# 文章图片url

try:

imgUrl = aaa[0].select('img')[0]['src']

except Exception:

imgUrl=""

# 新闻标题

try:

title = aaa[0]['title']

except Exception:

title = "标题为空"

print("标题",title,"\nurl:",href,"\n图片地址:",imgUrl)

print("==============================================================================================")

复制代码

这里增加了异常处理,主要是因为有些新闻可能没有标题、网址或图片。如果不进行异常处理,可能会导致我们爬取的中断。

过滤的有效信息

标题 标题为空

url: https://www.huxiu.com/article/211390.html

图片地址: https://img.huxiucdn.com/artic ... /210/|imageMogr2/strip/interlace/1/quality/85/format/jpg

==============================================================================================

标题 TFBOYS成员各自飞,商业价值天花板已现?

url: https://www.huxiu.com/article/214982.html

图片地址: https://img.huxiucdn.com/artic ... /210/|imageMogr2/strip/interlace/1/quality/85/format/jpg

==============================================================================================

标题 买手店江湖

url: https://www.huxiu.com/article/213703.html

图片地址: https://img.huxiucdn.com/artic ... /210/|imageMogr2/strip/interlace/1/quality/85/format/jpg

==============================================================================================

标题 iPhone X正式告诉我们,手机和相机开始分道扬镳

url: https://www.huxiu.com/article/214679.html

图片地址: https://img.huxiucdn.com/artic ... /210/|imageMogr2/strip/interlace/1/quality/85/format/jpg

==============================================================================================

标题 信用已被透支殆尽,乐视汽车或成贾跃亭弃子

url: https://www.huxiu.com/article/214962.html

图片地址: https://img.huxiucdn.com/artic ... /210/|imageMogr2/strip/interlace/1/quality/85/format/jpg

==============================================================================================

标题 别小看“搞笑诺贝尔奖”,要向好奇心致敬

url: https://www.huxiu.com/article/214867.html

图片地址: https://img.huxiucdn.com/artic ... /210/|imageMogr2/strip/interlace/1/quality/85/format/jpg

==============================================================================================

标题 10 年前改变世界的,可不止有 iPhone | 发车

url: https://www.huxiu.com/article/214954.html

图片地址: https://img.huxiucdn.com/artic ... /210/|imageMogr2/strip/interlace/1/quality/85/format/jpg

==============================================================================================

标题 感谢微博替我做主

url: https://www.huxiu.com/article/214908.html

图片地址: https://img.huxiucdn.com/artic ... /210/|imageMogr2/strip/interlace/1/quality/85/format/jpg

==============================================================================================

标题 苹果确认取消打赏抽成,但还有多少内容让你觉得值得掏腰包?

url: https://www.huxiu.com/article/215001.html

图片地址: https://img.huxiucdn.com/artic ... /210/|imageMogr2/strip/interlace/1/quality/85/format/jpg

==============================================================================================

标题 中国音乐的“全面付费”时代即将到来?

url: https://www.huxiu.com/article/214969.html

图片地址: https://img.huxiucdn.com/artic ... /210/|imageMogr2/strip/interlace/1/quality/85/format/jpg

==============================================================================================

标题 百丽退市启示录:“一代鞋王”如何与新生代消费者渐行渐远

url: https://www.huxiu.com/article/214964.html

图片地址: https://img.huxiucdn.com/artic ... /210/|imageMogr2/strip/interlace/1/quality/85/format/jpg

==============================================================================================

复制代码

这里我们抓取新闻网站新闻信息就大功告成了,完整代码贴在下面

from bs4 import BeautifulSoup

from urllib import request

import chardet

url = "https://www.huxiu.com"

response = request.urlopen(url)

html = response.read()

charset = chardet.detect(html)

html = html.decode(str(charset["encoding"])) # 设置抓取到的html的编码方式

# 使用剖析器为html.parser

soup = BeautifulSoup(html, 'html.parser')

# 获取到每一个class=hot-article-img的a节点

allList = soup.select('.hot-article-img')

#遍历列表,获取有效信息

for news in allList:

aaa = news.select('a')

# 只选择长度大于0的结果

if len(aaa) > 0:

# 文章链接

try:#如果抛出异常就代表为空

href = url + aaa[0]['href']

except Exception:

href=''

# 文章图片url

try:

imgUrl = aaa[0].select('img')[0]['src']

except Exception:

imgUrl=""

# 新闻标题

try:

title = aaa[0]['title']

except Exception:

title = "标题为空"

print("标题",title,"\nurl:",href,"\n图片地址:",imgUrl)

print("==============================================================================================")

复制代码

获取到数据后,我们还需要将数据存入数据库。只要存储在我们的数据库中,并且数据库中有数据,我们可以做后续的数据分析和处理,或者我们可以使用这些爬取的文章给app提供新闻api接口给你 查看全部

网页小说抓取 ios(

Python3爬取新闻网站新闻列表到这里稍微复杂点怎么办)

# 简单的网络爬虫

from urllib import request

import chardet

response = request.urlopen("http://www.jianshu.com/";)

html = response.read()

charset = chardet.detect(html)# {'language': '', 'encoding': 'utf-8', 'confidence': 0.99}

html = html.decode(str(charset["encoding"])) # 解码

print(html)

复制代码

由于抓到的html文档比较长,这里简单贴个帖子给大家看看。

..........后面省略一大堆

复制代码

这是Python3爬虫的简单介绍,是不是很简单,建议你敲几遍

三、Python3抓取网页中的图片并将图片保存到本地文件夹

目标

import re

import urllib.request

#爬取网页html

def getHtml(url):

page = urllib.request.urlopen(url)

html = page.read()

return html

html = getHtml("http://tieba.baidu.com/p/3205263090";)

html = html.decode('UTF-8')

#获取图片链接的方法

def getImg(html):

# 利用正则表达式匹配网页里的图片地址

reg = r'src="([.*\S]*\.jpg)" pic_ext="jpeg"'

imgre=re.compile(reg)

imglist=re.findall(imgre,html)

return imglist

imgList=getImg(html)

imgCount=0

#for把获取到的图片都下载到本地pic文件夹里,保存之前先在本地建一个pic文件夹

for imgPath in imgList:

f=open("../pic/"+str(imgCount)+".jpg",'wb')

f.write((urllib.request.urlopen(imgPath)).read())

f.close()

imgCount+=1

print("全部抓取完成")

复制代码

迫不及待想看看我爬过哪些美图

爬到 24 个女孩的照片是如此容易。是不是很简单。

四、Python3爬取新闻网站新闻列表

这里有点复杂,所以我会向你解释。

分析上图中我们要抓取的信息然后放到div中的a标签和img标签中,那么我们思考的是如何获取这些信息

这里会用到我们导入的BeautifulSoup4库,关键代码在这里

# 使用剖析器为html.parser

soup = BeautifulSoup(html, 'html.parser')

# 获取到每一个class=hot-article-img的a节点

allList = soup.select('.hot-article-img')

复制代码

上面代码得到的allList就是我们要获取的新闻列表,如下

[

,

,

,

,

,

,

,

,

,

,

]

复制代码

这里的数据是抓到的,但是太乱了,还有很多我们不想要的东西。让我们通过遍历提取我们的有效信息。

#遍历列表,获取有效信息

for news in allList:

aaa = news.select('a')

# 只选择长度大于0的结果

if len(aaa) > 0:

# 文章链接

try:#如果抛出异常就代表为空

href = url + aaa[0]['href']

except Exception:

href=''

# 文章图片url

try:

imgUrl = aaa[0].select('img')[0]['src']

except Exception:

imgUrl=""

# 新闻标题

try:

title = aaa[0]['title']

except Exception:

title = "标题为空"

print("标题",title,"\nurl:",href,"\n图片地址:",imgUrl)

print("==============================================================================================")

复制代码

这里增加了异常处理,主要是因为有些新闻可能没有标题、网址或图片。如果不进行异常处理,可能会导致我们爬取的中断。

过滤的有效信息

标题 标题为空

url: https://www.huxiu.com/article/211390.html

图片地址: https://img.huxiucdn.com/artic ... /210/|imageMogr2/strip/interlace/1/quality/85/format/jpg

==============================================================================================

标题 TFBOYS成员各自飞,商业价值天花板已现?

url: https://www.huxiu.com/article/214982.html

图片地址: https://img.huxiucdn.com/artic ... /210/|imageMogr2/strip/interlace/1/quality/85/format/jpg

==============================================================================================

标题 买手店江湖

url: https://www.huxiu.com/article/213703.html

图片地址: https://img.huxiucdn.com/artic ... /210/|imageMogr2/strip/interlace/1/quality/85/format/jpg

==============================================================================================

标题 iPhone X正式告诉我们,手机和相机开始分道扬镳

url: https://www.huxiu.com/article/214679.html

图片地址: https://img.huxiucdn.com/artic ... /210/|imageMogr2/strip/interlace/1/quality/85/format/jpg

==============================================================================================

标题 信用已被透支殆尽,乐视汽车或成贾跃亭弃子

url: https://www.huxiu.com/article/214962.html

图片地址: https://img.huxiucdn.com/artic ... /210/|imageMogr2/strip/interlace/1/quality/85/format/jpg

==============================================================================================

标题 别小看“搞笑诺贝尔奖”,要向好奇心致敬

url: https://www.huxiu.com/article/214867.html

图片地址: https://img.huxiucdn.com/artic ... /210/|imageMogr2/strip/interlace/1/quality/85/format/jpg

==============================================================================================

标题 10 年前改变世界的,可不止有 iPhone | 发车

url: https://www.huxiu.com/article/214954.html

图片地址: https://img.huxiucdn.com/artic ... /210/|imageMogr2/strip/interlace/1/quality/85/format/jpg

==============================================================================================

标题 感谢微博替我做主

url: https://www.huxiu.com/article/214908.html

图片地址: https://img.huxiucdn.com/artic ... /210/|imageMogr2/strip/interlace/1/quality/85/format/jpg

==============================================================================================

标题 苹果确认取消打赏抽成,但还有多少内容让你觉得值得掏腰包?

url: https://www.huxiu.com/article/215001.html

图片地址: https://img.huxiucdn.com/artic ... /210/|imageMogr2/strip/interlace/1/quality/85/format/jpg

==============================================================================================

标题 中国音乐的“全面付费”时代即将到来?

url: https://www.huxiu.com/article/214969.html

图片地址: https://img.huxiucdn.com/artic ... /210/|imageMogr2/strip/interlace/1/quality/85/format/jpg

==============================================================================================

标题 百丽退市启示录:“一代鞋王”如何与新生代消费者渐行渐远

url: https://www.huxiu.com/article/214964.html

图片地址: https://img.huxiucdn.com/artic ... /210/|imageMogr2/strip/interlace/1/quality/85/format/jpg

==============================================================================================

复制代码

这里我们抓取新闻网站新闻信息就大功告成了,完整代码贴在下面

from bs4 import BeautifulSoup

from urllib import request

import chardet

url = "https://www.huxiu.com"

response = request.urlopen(url)

html = response.read()

charset = chardet.detect(html)

html = html.decode(str(charset["encoding"])) # 设置抓取到的html的编码方式

# 使用剖析器为html.parser

soup = BeautifulSoup(html, 'html.parser')

# 获取到每一个class=hot-article-img的a节点

allList = soup.select('.hot-article-img')

#遍历列表,获取有效信息

for news in allList:

aaa = news.select('a')

# 只选择长度大于0的结果

if len(aaa) > 0:

# 文章链接

try:#如果抛出异常就代表为空

href = url + aaa[0]['href']

except Exception:

href=''

# 文章图片url

try:

imgUrl = aaa[0].select('img')[0]['src']

except Exception:

imgUrl=""

# 新闻标题

try:

title = aaa[0]['title']

except Exception:

title = "标题为空"

print("标题",title,"\nurl:",href,"\n图片地址:",imgUrl)

print("==============================================================================================")

复制代码

获取到数据后,我们还需要将数据存入数据库。只要存储在我们的数据库中,并且数据库中有数据,我们可以做后续的数据分析和处理,或者我们可以使用这些爬取的文章给app提供新闻api接口给你

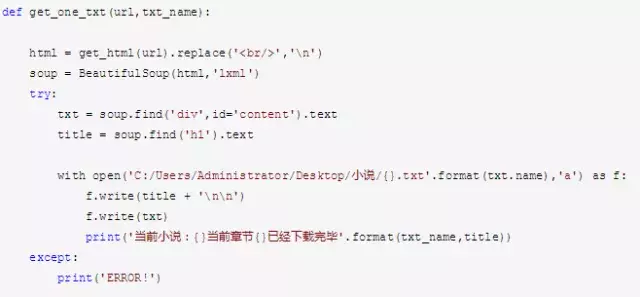

网页小说抓取 ios( Python爬虫私信学习资料领取目标的案例源码! )

网站优化 • 优采云 发表了文章 • 0 个评论 • 94 次浏览 • 2022-01-28 23:03

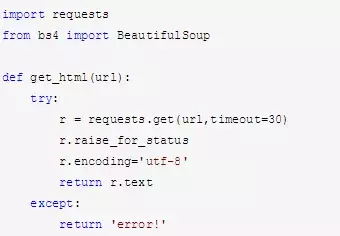

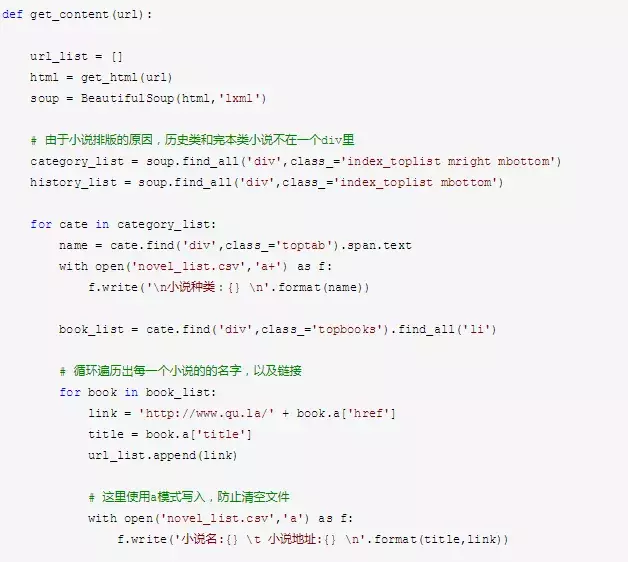

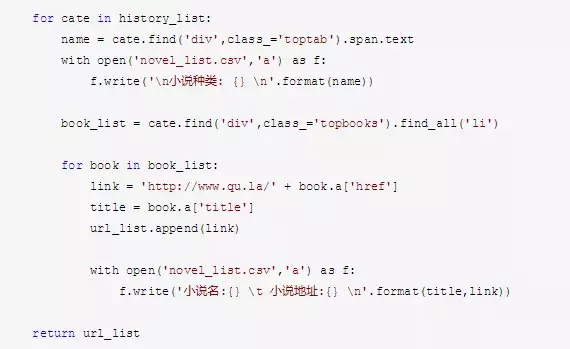

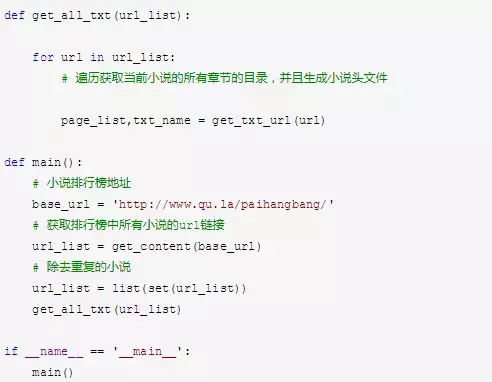

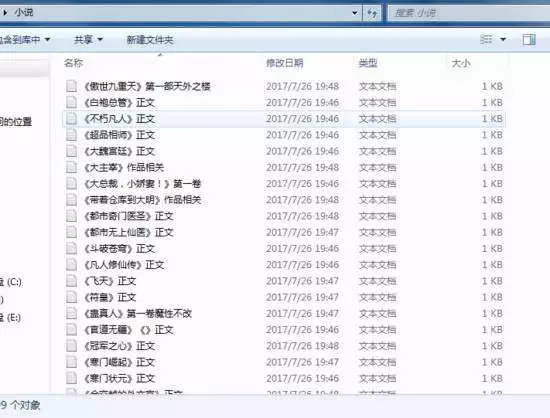

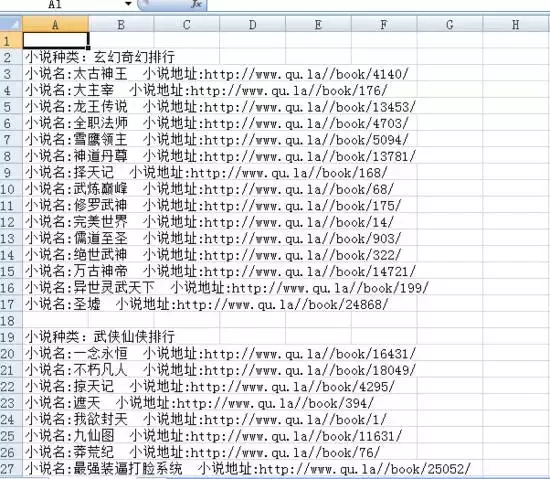

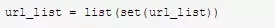

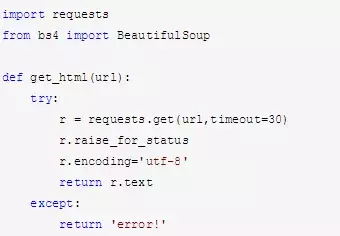

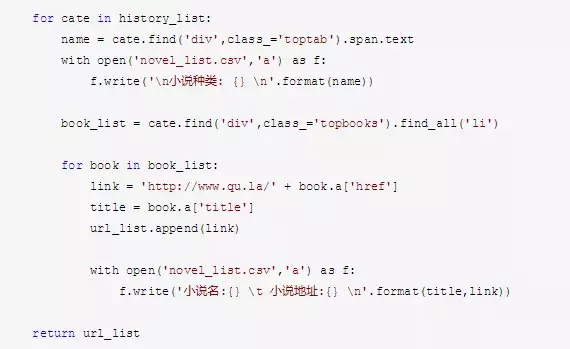

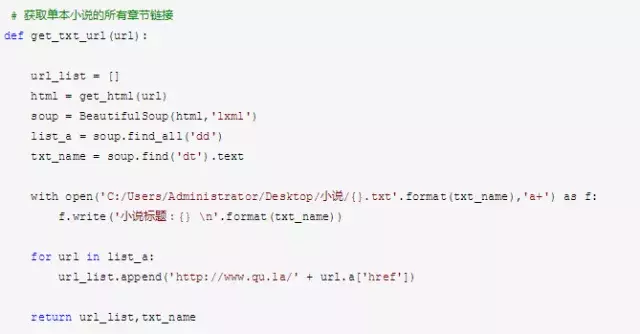

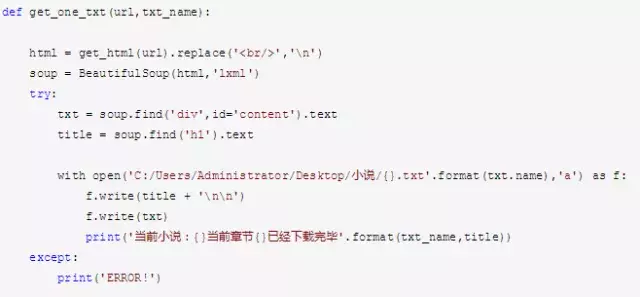

Python爬虫私信学习资料领取目标的案例源码!

)

想收到更多关于Python爬虫的案例源码,可以关注小编私信领取学习资料

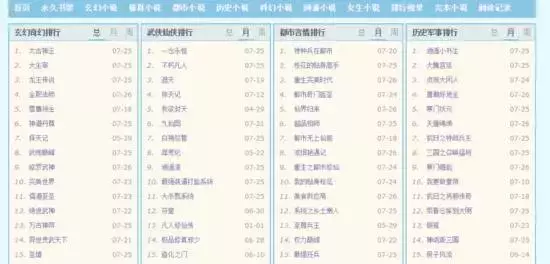

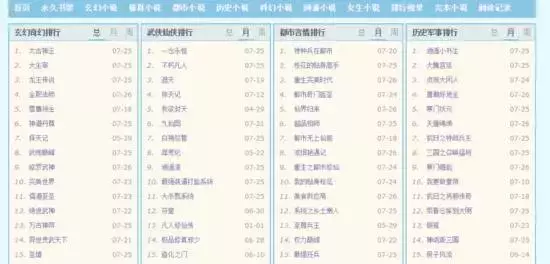

1.目标

排行榜地址:

在各个排名旁边找到每部小说的名称,以及 网站 中的链接。

2.观察页面结构

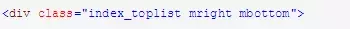

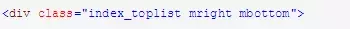

很容易看出每个类别都收录在:

之中,

这个组织良好的 网站 极大地方便了爬虫的编写。

找到当前页面所有小说的链接,并保存在列表中。

3.列表去重提示

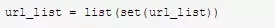

即使是不同类别的小说,也会在排行榜中反复出现。

这样一来,就会无形中浪费大量资源,尤其是面对大量网页的爬取。

只需一行代码即可解决此问题:

此处调用列表构造函数集:这确保列表中没有重复元素。

4.代码实现

模块化、函数式编程是一个很好的习惯,坚持把每个独立的函数都写成一个函数,这样会让代码简单且可重用。

获取该小说每个章节的url地址,并创建小说文件

5.缺点

这次爬虫写得这么流畅,更多是因为网站爬取没有反爬技术,文章分类清晰,结构美观。

不过按照这篇文章爬小说的思路,我粗略算了一下:一本文章需要:0.5s,一本小说(约1000条):8.5分钟,所有排行榜(60 份):8.5 小时!

那么,这个单线程爬虫的速度如何提升呢?

自己写一个多线程模块?

其实还有更好的办法:Scrapy框架

以后可以在这里重构代码,速度会提升几十倍甚至上百倍!这其实就是多线程的威力!

查看全部

网页小说抓取 ios(

Python爬虫私信学习资料领取目标的案例源码!

)

想收到更多关于Python爬虫的案例源码,可以关注小编私信领取学习资料

1.目标

排行榜地址:

在各个排名旁边找到每部小说的名称,以及 网站 中的链接。

2.观察页面结构

很容易看出每个类别都收录在:

之中,

这个组织良好的 网站 极大地方便了爬虫的编写。

找到当前页面所有小说的链接,并保存在列表中。

3.列表去重提示

即使是不同类别的小说,也会在排行榜中反复出现。

这样一来,就会无形中浪费大量资源,尤其是面对大量网页的爬取。

只需一行代码即可解决此问题:

此处调用列表构造函数集:这确保列表中没有重复元素。

4.代码实现

模块化、函数式编程是一个很好的习惯,坚持把每个独立的函数都写成一个函数,这样会让代码简单且可重用。

获取该小说每个章节的url地址,并创建小说文件

5.缺点

这次爬虫写得这么流畅,更多是因为网站爬取没有反爬技术,文章分类清晰,结构美观。

不过按照这篇文章爬小说的思路,我粗略算了一下:一本文章需要:0.5s,一本小说(约1000条):8.5分钟,所有排行榜(60 份):8.5 小时!

那么,这个单线程爬虫的速度如何提升呢?

自己写一个多线程模块?

其实还有更好的办法:Scrapy框架

以后可以在这里重构代码,速度会提升几十倍甚至上百倍!这其实就是多线程的威力!

网页小说抓取 ios(用宜好点下载网站)

网站优化 • 优采云 发表了文章 • 0 个评论 • 77 次浏览 • 2022-01-28 19:05

我一一尝试,复制和粘贴。您可以使用移位

去百度搜索Abada电子书下载网站进入,先选择一个类别(如穿越),然后选择一本书点击,会出现书的介绍,将鼠标拖到底部,然后选择下载到电脑,共有三种下载方式,选择迅雷下载或者以上其中一种,然后选择下载到的地址(之前安装迅雷,迅雷5免费下载,迅雷7没有)

如果要下载的内容有目录,可以使用小说下载阅读器。

本软件可以将一个目录中的所有链接下载到电脑中,并且可以自动过滤广告等词。

下载完成后,可以在右侧选择要合并的章节标题,在键盘上按Ctrl+T,打开合并为txt文档的对话框。

你好()由于种种原因,几乎所有手机网站都无法下载小说!选择在线阅读,选择一个更好的地方,可以在手机上看小说,而且不需要太多流量!其实Android和ios手机用户都可以选择Yiso手机搜索的“Yisoo+”。它是一个聚合的手机应用程序。里面的小说类别和原版一搜小说的类别一样,都提供离线下载。您可以在下载之前缓存您喜欢的小说。同时,“Yisoo+”还提供新闻、小说和图片。还支持一键分享到微博、微信等,更人性化,为你节省流量!小说的种类也很齐全,阅读和阅读器一样,也更流畅!

有网站在线下载器。该页面绝对可以下载。示例:超

如何将网页上的小说批量复制并保存为txt。小说是逐章独立网页-:这类软件的网页文字很多采集大师:IbookBox网络小说批量下载阅读器:我列出如果你有一些具体的不满意,也可以找找你自己

怎么复制小说全文-:ctrl+A全选,然后复制到记事本或者word文档

如何快速复制网站中的小说?:Ctrl+c复制

我想把所有的小说都看完,但只能一本一本的复制粘贴。有没有办法下载整本小说?:使用迅雷或迅雷下载,在网页界面右击,选择使用“迅雷或迅雷下载所有链接”,在小对话框中,去掉所有其他勾选,只留下小说,就是这样。

如何快速粘贴和复制网页上的文本:CTRL+a 全部复制,CTRL+V 粘贴,这样可能会更快。

如何批量复制网页上一些带链接的小文字??:可以得到一个链接来实现所有的效果,仅此而已。指向这个整体包可以达到你想要的..

小说全文如何复制:有的要先下载再下载。不,按照上面说的自己复制

网站-中如何复制小说:如果是文本格式的小说,可以点击网页右上角的“文件”两个字,然后选择“另存为”。不要急于选择“保存”。) 在那个栏目下,有一个保存类型,选择另存为txt格式,就这样!如果是图片格式,那肯定有专门的把图片转成文字的工具。如果很麻烦,可以搜索一下。

如何自动复制 网站 上的所有 文章?- :如果你有网站的控制权限,可以直接从数据库中导出。WEBZIP等工具是从全站下载的,然后根据下载的HTML文件慢慢整理。

请问,我想下载一本小说,如何将分块网页上的文字合并到一个界面并全部复制下来-:移动端。1.首先点击UC浏览器。在@>进入阅读模式) 2 全文复制(UC浏览器具有一键复制网页中所有文字的功能)3.打开es文件管理器。创建一个txt文档。在文档中编辑直接复制4.复制一个章节后,在浏览器中直接向下滑动进入下一章节。然后按照上面的步骤直到最后复制整本小说。非常快 查看全部

网页小说抓取 ios(用宜好点下载网站)

我一一尝试,复制和粘贴。您可以使用移位

去百度搜索Abada电子书下载网站进入,先选择一个类别(如穿越),然后选择一本书点击,会出现书的介绍,将鼠标拖到底部,然后选择下载到电脑,共有三种下载方式,选择迅雷下载或者以上其中一种,然后选择下载到的地址(之前安装迅雷,迅雷5免费下载,迅雷7没有)

如果要下载的内容有目录,可以使用小说下载阅读器。

本软件可以将一个目录中的所有链接下载到电脑中,并且可以自动过滤广告等词。

下载完成后,可以在右侧选择要合并的章节标题,在键盘上按Ctrl+T,打开合并为txt文档的对话框。

你好()由于种种原因,几乎所有手机网站都无法下载小说!选择在线阅读,选择一个更好的地方,可以在手机上看小说,而且不需要太多流量!其实Android和ios手机用户都可以选择Yiso手机搜索的“Yisoo+”。它是一个聚合的手机应用程序。里面的小说类别和原版一搜小说的类别一样,都提供离线下载。您可以在下载之前缓存您喜欢的小说。同时,“Yisoo+”还提供新闻、小说和图片。还支持一键分享到微博、微信等,更人性化,为你节省流量!小说的种类也很齐全,阅读和阅读器一样,也更流畅!

有网站在线下载器。该页面绝对可以下载。示例:超

如何将网页上的小说批量复制并保存为txt。小说是逐章独立网页-:这类软件的网页文字很多采集大师:IbookBox网络小说批量下载阅读器:我列出如果你有一些具体的不满意,也可以找找你自己

怎么复制小说全文-:ctrl+A全选,然后复制到记事本或者word文档

如何快速复制网站中的小说?:Ctrl+c复制

我想把所有的小说都看完,但只能一本一本的复制粘贴。有没有办法下载整本小说?:使用迅雷或迅雷下载,在网页界面右击,选择使用“迅雷或迅雷下载所有链接”,在小对话框中,去掉所有其他勾选,只留下小说,就是这样。

如何快速粘贴和复制网页上的文本:CTRL+a 全部复制,CTRL+V 粘贴,这样可能会更快。

如何批量复制网页上一些带链接的小文字??:可以得到一个链接来实现所有的效果,仅此而已。指向这个整体包可以达到你想要的..

小说全文如何复制:有的要先下载再下载。不,按照上面说的自己复制

网站-中如何复制小说:如果是文本格式的小说,可以点击网页右上角的“文件”两个字,然后选择“另存为”。不要急于选择“保存”。) 在那个栏目下,有一个保存类型,选择另存为txt格式,就这样!如果是图片格式,那肯定有专门的把图片转成文字的工具。如果很麻烦,可以搜索一下。

如何自动复制 网站 上的所有 文章?- :如果你有网站的控制权限,可以直接从数据库中导出。WEBZIP等工具是从全站下载的,然后根据下载的HTML文件慢慢整理。

请问,我想下载一本小说,如何将分块网页上的文字合并到一个界面并全部复制下来-:移动端。1.首先点击UC浏览器。在@>进入阅读模式) 2 全文复制(UC浏览器具有一键复制网页中所有文字的功能)3.打开es文件管理器。创建一个txt文档。在文档中编辑直接复制4.复制一个章节后,在浏览器中直接向下滑动进入下一章节。然后按照上面的步骤直到最后复制整本小说。非常快

网页小说抓取 ios(软件简介《小说网站捕捉器免费版》软件特色自定义规则)

网站优化 • 优采云 发表了文章 • 0 个评论 • 92 次浏览 • 2022-01-25 20:05

软件说明

《小说网站捕手免费版》是一款非常小巧方便的小说采集下载工具。本软件可以通过html网站代码抓取目标网站的新奇资源,不仅可以直接Capture,还可以设置目标,范围筛选后有针对性的抓取,而且目标强,你可设置多个条件,帮助您更快找到想要阅读的小说资源,操作简单,一键获取所有内容。

功能介绍

本软件可以通过小说网站的html网页源码抓书,分析关键信息的规则,最终输出抓书(支持txt、ePub、zip格式输出)。

这个软件可以说好用也好难用,比如简单的从网站抓书,直接从自带的100多个预设网站抓书(需要浏览通过你可以用浏览器搜索你想下载的书,然后复制链接到入口网址),无需分析复杂的源码。对于逻辑思维能力强的用户,通过分析小说网站的源码,制定网站的抓包规则,基本可以应对大部分小说网站。

软件功能

自定义规则抓取,可以文章抓取大部分小说网,个别网站分类书籍详细分类,还支持多本抓取;

自带海量预测网站,不定义规则的用户可以直接套用,也可以抓取自己需要的小说;

自带源码查看器,提供链接分析、关键定位、标签分割等工具;

对于大型小说,任务暂存数据库后,可随意中断和恢复;

图书提供多种输出方式:章节文件、独立文本文件、压缩包、ePub电子书等;

支持任务导入,即从文本文件和带有章节页面链接的excel文档中导入任务进行抓取;

所有组件都支持提示信息,即光标停止后会显示相关提示,大部分操作都支持状态栏提示,使用更方便;

支持添加、修改、导入、导出、排序、删除预设网站;

附带小工具

ePub电子书制作分解工具,支持分章存储的书籍生成ePub文件,也可以将ePub文件分解成多章文本文件。

软件界面

主界面

任务管理

系统设置 + ePub 小部件

分析代码窗口 查看全部

网页小说抓取 ios(软件简介《小说网站捕捉器免费版》软件特色自定义规则)

软件说明

《小说网站捕手免费版》是一款非常小巧方便的小说采集下载工具。本软件可以通过html网站代码抓取目标网站的新奇资源,不仅可以直接Capture,还可以设置目标,范围筛选后有针对性的抓取,而且目标强,你可设置多个条件,帮助您更快找到想要阅读的小说资源,操作简单,一键获取所有内容。

功能介绍

本软件可以通过小说网站的html网页源码抓书,分析关键信息的规则,最终输出抓书(支持txt、ePub、zip格式输出)。

这个软件可以说好用也好难用,比如简单的从网站抓书,直接从自带的100多个预设网站抓书(需要浏览通过你可以用浏览器搜索你想下载的书,然后复制链接到入口网址),无需分析复杂的源码。对于逻辑思维能力强的用户,通过分析小说网站的源码,制定网站的抓包规则,基本可以应对大部分小说网站。

软件功能

自定义规则抓取,可以文章抓取大部分小说网,个别网站分类书籍详细分类,还支持多本抓取;

自带海量预测网站,不定义规则的用户可以直接套用,也可以抓取自己需要的小说;

自带源码查看器,提供链接分析、关键定位、标签分割等工具;

对于大型小说,任务暂存数据库后,可随意中断和恢复;

图书提供多种输出方式:章节文件、独立文本文件、压缩包、ePub电子书等;

支持任务导入,即从文本文件和带有章节页面链接的excel文档中导入任务进行抓取;

所有组件都支持提示信息,即光标停止后会显示相关提示,大部分操作都支持状态栏提示,使用更方便;

支持添加、修改、导入、导出、排序、删除预设网站;

附带小工具

ePub电子书制作分解工具,支持分章存储的书籍生成ePub文件,也可以将ePub文件分解成多章文本文件。

软件界面

主界面

任务管理

系统设置 + ePub 小部件

分析代码窗口

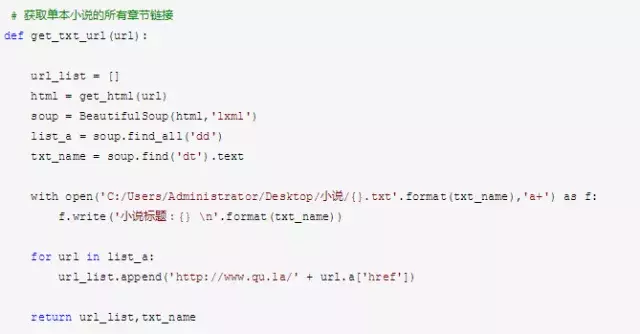

网页小说抓取 ios(上班想爬取笔阁小说?找个目的学习python分享)

网站优化 • 优采云 发表了文章 • 0 个评论 • 103 次浏览 • 2022-01-11 01:08

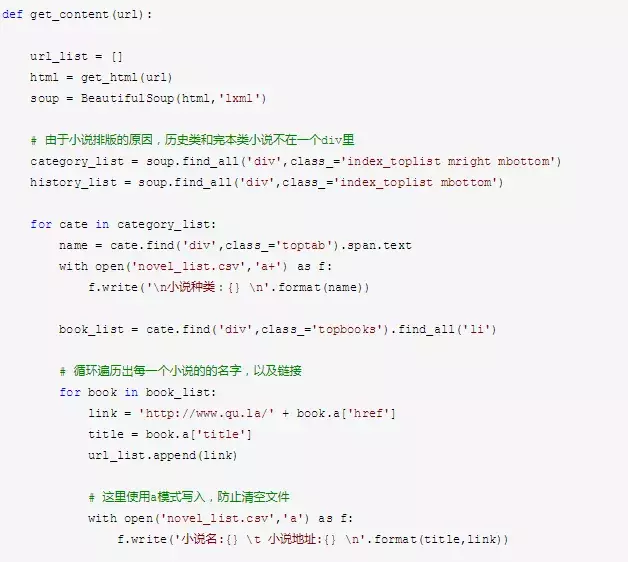

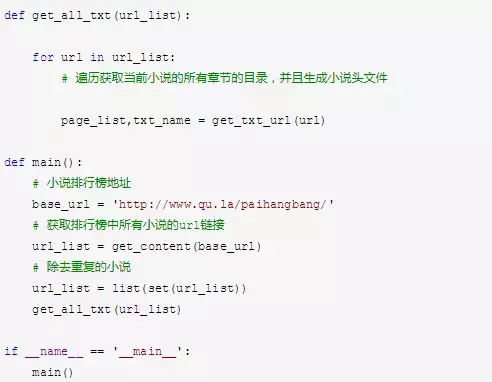

想在工作中钓鱼?为了找鱼方便,今天写了一个爬毕格小说的程序。嗯,其实我是在找一个学习python的目的,分享一下。

1. 先导入相关模块

import os<br />

import requests<br />

from bs4 import BeautifulSoup<br />

2. 向 网站 发送请求并获取 网站 数据

网站链接的最后一个数字是一本书的id值,一个数字对应一本小说。我们以id为1的小说为例。

进入网站后发现有章节列表,那么我们先完成小说列表名称的爬取

# 声明请求头<br />

headers = {<br />

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/88.0.4324.182 Safari/537.36'<br />

}

# 创建保存小说文本的文件夹<br />

if not os.path.exists('./小说'):<br />

os.mkdir('./小说/')

# 访问网站并获取页面数据<br />

response = requests.get('http://www.biquw.com/book/1/').text<br />

print(response)<br />

【外链图片传输失败,源站可能有防盗链机制,建议保存图片直接上传(img-Uu2ddyQB-32)(.\素材图片\中文显示乱码.png)]

写过这个地方的学生可能发现了一个问题。正常去访问网站,为什么返回的数据是乱码?

这是因为页面html的编码格式和我们用python访问和获取数据的数据的解码格式不一致。python默认的解码方式是utf-8,但是页面编码可能是GBK或者GB2312等,所以我们需要让python代码所在页面的解码方式自动变化

#### 重新编写访问代码<br />

```python<br />

response = requests.get('http://www.biquw.com/book/1/')<br />

response.encoding = response.apparent_encoding<br />

print(response.text)

'''<br />

这种方式返回的中文数据才是正确的<br />

'''<br />

3. 获取页面数据后提取数据

通过正确的解码方式得到页面数据后,需要完成静态页面分析。我们需要从整个网页数据(章节列表数据)中获取我们想要的数据

首先打开浏览器,按F12调出开发者工具。选择元素选择器。在页面中选择我们想要的数据,定位到数据所在的元素标签。

'''<br />

根据上图所示,数据是保存在a标签当中的。a的父标签为li,li的父标签为ul标签,ul标签之上为div标签。所以如果想要获取整个页面的小说章节数据,那么需要先获取div标签。并且div标签中包含了class属性,我们可以通过class属性获取指定的div标签,详情看代码~<br />

'''<br />

# lxml: html解析库 将html代码转成python对象,python可以对html代码进行控制<br />

soup = BeautifulSoup(response.text, 'lxml')<br />

book_list = soup.find('div', class_='book_list').find_all('a')<br />

# soup对象获取批量数据后返回的是一个列表,我们可以对列表进行迭代提取<br />

for book in book_list:<br />

book_name = book.text<br />

# 获取到列表数据之后,需要获取文章详情页的链接,链接在a标签的href属性中<br />

book_url = book['href']<br />

4.获取小说详情页链接后,再次访问详情页,获取文章的数据

book_info_html = requests.get('http://www.biquw.com/book/1/' + book_url, headers=headers)<br />

book_info_html.encoding = book_info_html.apparent_encoding<br />

soup = BeautifulSoup(book_info_html.text, 'lxml')<br />

5. 对小说详情页进行静态页面分析

info = soup.find('div', id='htmlContent')<br />

print(info.text)<br />

6. 资料下载

with open('./小说/' + book_name + '.txt', 'a', encoding='utf-8') as f:<br />

f.write(info.text)<br />

最后再来看看代码效果~

抓取的数据

文章本文到此结束,只是想感谢一些阅读我的人文章。

退休后,我一直在学习如何写 文章。说实话,每次在后台看到一些读者的回复,我都觉得很欣慰,所以想把自己采集的一些编程干货贡献给大家,回馈每一位读者,希望对大家有所帮助。

干货主要有:

①2000多本Python电子书(主流经典书籍应该都有)

②Python标准库资料(最全中文版)

③项目源码(四十或五十个有趣经典的培训项目及源码)

④Python基础入门视频等(适合小白学习)

*如果可以使用,可以直接拿走。你可以在我的QQ技术交流群里自己带走(无广告),群号是980758007。*

python爬取笔曲格小说,有趣实用更多相关文章bs4爬取笔曲格小说

参考链接:Module:requests,bs4,queue,sys,time Step:Give URL-->Access U...

Jsoup-基于Java的Web爬虫

注意力!仅供学习交流使用,请勿在歪歪扭扭的地方使用!技术只是工具!关键在于使用!今天,我接触到一个有趣的框架,它充当网络爬虫。他可以像 JS 一样提取网页的内容,体验 Jsoup 服务器生成会话(唯一)。会话ID ... 查看全部

网页小说抓取 ios(上班想爬取笔阁小说?找个目的学习python分享)

想在工作中钓鱼?为了找鱼方便,今天写了一个爬毕格小说的程序。嗯,其实我是在找一个学习python的目的,分享一下。

1. 先导入相关模块

import os<br />

import requests<br />

from bs4 import BeautifulSoup<br />

2. 向 网站 发送请求并获取 网站 数据

网站链接的最后一个数字是一本书的id值,一个数字对应一本小说。我们以id为1的小说为例。

进入网站后发现有章节列表,那么我们先完成小说列表名称的爬取

# 声明请求头<br />

headers = {<br />

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/88.0.4324.182 Safari/537.36'<br />

}

# 创建保存小说文本的文件夹<br />

if not os.path.exists('./小说'):<br />

os.mkdir('./小说/')

# 访问网站并获取页面数据<br />

response = requests.get('http://www.biquw.com/book/1/').text<br />

print(response)<br />

【外链图片传输失败,源站可能有防盗链机制,建议保存图片直接上传(img-Uu2ddyQB-32)(.\素材图片\中文显示乱码.png)]

写过这个地方的学生可能发现了一个问题。正常去访问网站,为什么返回的数据是乱码?

这是因为页面html的编码格式和我们用python访问和获取数据的数据的解码格式不一致。python默认的解码方式是utf-8,但是页面编码可能是GBK或者GB2312等,所以我们需要让python代码所在页面的解码方式自动变化

#### 重新编写访问代码<br />

```python<br />

response = requests.get('http://www.biquw.com/book/1/')<br />

response.encoding = response.apparent_encoding<br />

print(response.text)

'''<br />

这种方式返回的中文数据才是正确的<br />

'''<br />

3. 获取页面数据后提取数据

通过正确的解码方式得到页面数据后,需要完成静态页面分析。我们需要从整个网页数据(章节列表数据)中获取我们想要的数据

首先打开浏览器,按F12调出开发者工具。选择元素选择器。在页面中选择我们想要的数据,定位到数据所在的元素标签。

'''<br />

根据上图所示,数据是保存在a标签当中的。a的父标签为li,li的父标签为ul标签,ul标签之上为div标签。所以如果想要获取整个页面的小说章节数据,那么需要先获取div标签。并且div标签中包含了class属性,我们可以通过class属性获取指定的div标签,详情看代码~<br />

'''<br />

# lxml: html解析库 将html代码转成python对象,python可以对html代码进行控制<br />

soup = BeautifulSoup(response.text, 'lxml')<br />

book_list = soup.find('div', class_='book_list').find_all('a')<br />

# soup对象获取批量数据后返回的是一个列表,我们可以对列表进行迭代提取<br />

for book in book_list:<br />

book_name = book.text<br />

# 获取到列表数据之后,需要获取文章详情页的链接,链接在a标签的href属性中<br />

book_url = book['href']<br />

4.获取小说详情页链接后,再次访问详情页,获取文章的数据

book_info_html = requests.get('http://www.biquw.com/book/1/' + book_url, headers=headers)<br />

book_info_html.encoding = book_info_html.apparent_encoding<br />

soup = BeautifulSoup(book_info_html.text, 'lxml')<br />

5. 对小说详情页进行静态页面分析

info = soup.find('div', id='htmlContent')<br />

print(info.text)<br />

6. 资料下载

with open('./小说/' + book_name + '.txt', 'a', encoding='utf-8') as f:<br />

f.write(info.text)<br />

最后再来看看代码效果~

抓取的数据

文章本文到此结束,只是想感谢一些阅读我的人文章。

退休后,我一直在学习如何写 文章。说实话,每次在后台看到一些读者的回复,我都觉得很欣慰,所以想把自己采集的一些编程干货贡献给大家,回馈每一位读者,希望对大家有所帮助。

干货主要有:

①2000多本Python电子书(主流经典书籍应该都有)

②Python标准库资料(最全中文版)

③项目源码(四十或五十个有趣经典的培训项目及源码)

④Python基础入门视频等(适合小白学习)

*如果可以使用,可以直接拿走。你可以在我的QQ技术交流群里自己带走(无广告),群号是980758007。*

python爬取笔曲格小说,有趣实用更多相关文章bs4爬取笔曲格小说

参考链接:Module:requests,bs4,queue,sys,time Step:Give URL-->Access U...

Jsoup-基于Java的Web爬虫

注意力!仅供学习交流使用,请勿在歪歪扭扭的地方使用!技术只是工具!关键在于使用!今天,我接触到一个有趣的框架,它充当网络爬虫。他可以像 JS 一样提取网页的内容,体验 Jsoup 服务器生成会话(唯一)。会话ID ...

网页小说抓取 ios(利用能提取网页小说的app,批量下载网站所有小说)

网站优化 • 优采云 发表了文章 • 0 个评论 • 478 次浏览 • 2022-01-04 04:01

使用可以提取网络小说的app,批量下载所有小说网站。现在给大家推荐一款免费简单的网络小说下载器,使用大叔小说下载器,它不仅具有小说爬虫下载器app的功能,还可以批量提取网络小说,还可以作为干净的本地阅读器app使用。下载小说后,可以直接阅读小说。不知道怎么下载电子书软件的朋友快来最火的软件站下载吧。

基本介绍

这是一款网络小说下载爬虫软件,可以帮助用户批量下载网络小说。软件功能丰富,包括TXT小说下载、TXT小说阅读、有声小说下载。有声小说不仅支持下载,还可以在线听书。如果使用TXT小说下载功能,可以批量下载所有网站小说。如果你还不知道怎么下载电子书软件,快来看看吧。将TXT小说下载到本地后,可以使用电脑小说阅读器阅读,也可以使用软件本身阅读小说。

如何使用

1. 在本站下载并解压这款新颖的爬虫下载器应用。好用,搜索小说,解析目录,选择要下载的章节(可以shift),点击章节列表查看正文内容,点击章节正文被选中,空白处为要查看的内容,可以右击。

2. 过滤掉不需要的内容(加范围,去掉广告),范围最好是预定网页源码的内容。点击添加到书架或下载,即可进入下载管理查看进度。

3. 如果下载失败次数过多,请增加每个线程下载的章节数。可以直接取目录链接进行申诉操作。如果是动态网页,记得开启动态网页支持。切换规则不需要重新解析,只需要重新解析章节相关的规则。

4. 支持有声小说下载,搜索有声小说,添加书架直接选择要开始下载的,发现失败较多,增加每线程下载章节数,增加延迟。

小编推荐

以上是这款小说下载软件免费版的完整介绍。最热门的软件网站有更多类似的小说下载软件。有需要的朋友快来下载体验吧。这是另外两个有用的。小说下载软件:电脑版全小说下载器、远天湾小说下载器。 查看全部

网页小说抓取 ios(利用能提取网页小说的app,批量下载网站所有小说)

使用可以提取网络小说的app,批量下载所有小说网站。现在给大家推荐一款免费简单的网络小说下载器,使用大叔小说下载器,它不仅具有小说爬虫下载器app的功能,还可以批量提取网络小说,还可以作为干净的本地阅读器app使用。下载小说后,可以直接阅读小说。不知道怎么下载电子书软件的朋友快来最火的软件站下载吧。

基本介绍

这是一款网络小说下载爬虫软件,可以帮助用户批量下载网络小说。软件功能丰富,包括TXT小说下载、TXT小说阅读、有声小说下载。有声小说不仅支持下载,还可以在线听书。如果使用TXT小说下载功能,可以批量下载所有网站小说。如果你还不知道怎么下载电子书软件,快来看看吧。将TXT小说下载到本地后,可以使用电脑小说阅读器阅读,也可以使用软件本身阅读小说。

如何使用

1. 在本站下载并解压这款新颖的爬虫下载器应用。好用,搜索小说,解析目录,选择要下载的章节(可以shift),点击章节列表查看正文内容,点击章节正文被选中,空白处为要查看的内容,可以右击。

2. 过滤掉不需要的内容(加范围,去掉广告),范围最好是预定网页源码的内容。点击添加到书架或下载,即可进入下载管理查看进度。

3. 如果下载失败次数过多,请增加每个线程下载的章节数。可以直接取目录链接进行申诉操作。如果是动态网页,记得开启动态网页支持。切换规则不需要重新解析,只需要重新解析章节相关的规则。

4. 支持有声小说下载,搜索有声小说,添加书架直接选择要开始下载的,发现失败较多,增加每线程下载章节数,增加延迟。

小编推荐

以上是这款小说下载软件免费版的完整介绍。最热门的软件网站有更多类似的小说下载软件。有需要的朋友快来下载体验吧。这是另外两个有用的。小说下载软件:电脑版全小说下载器、远天湾小说下载器。

网页小说抓取 ios( 苹果需要自己对网络进行索引呢?外媒9to5mac提醒 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 76 次浏览 • 2022-01-02 14:12

苹果需要自己对网络进行索引呢?外媒9to5mac提醒

)

您一定听说过 Apple 的 iPhone、iPad 或 iMac,但您听说过 Applebot 吗?

实际上,Applebot 是 Apple 的网络爬虫,Siri 和 Spotlight Suggestions 等产品都使用了这项技术。

什么是网络爬虫?简单的说就是一个用来自动浏览互联网的机器人,主要用来编制网络索引。爬虫可以保存自己访问过的页面,以便搜索引擎生成索引供用户搜索。

苹果的网络爬虫最早出现在2015年,当时网站管理员看到了一个IP地址为17的网络爬虫,这个IP地址块是苹果的。

随后,Apple 承认它正在使用网络爬虫。

知名 iOS 开发者 Benjamin Mayo 表示 Applebot 是由 Go 语言开发的。在 iOS 9 发布之前,Applebot 完全依赖于苹果办公室的四台 Mac Pro,这四台电脑每天可以爬行接近 10 亿。网页。

有趣的是,在 Applebot 推出的第一周,它几乎断开了 Apple 内部 DNS 服务器的连接。好在修改了自己的DNS解析和缓存,缓解了压力。

问题是,Siri 主要使用 Bing 和 Wolfram Alpha 进行网页搜索,那么为什么 Apple 需要自己为网页编制索引?

外媒 9to5mac 认为 Applebot 是一种补充现有第三方搜索引擎的工具,以确保 Siri 和 Spotlight 能够提供最佳搜索结果。

查看全部

网页小说抓取 ios(

苹果需要自己对网络进行索引呢?外媒9to5mac提醒

)

您一定听说过 Apple 的 iPhone、iPad 或 iMac,但您听说过 Applebot 吗?

实际上,Applebot 是 Apple 的网络爬虫,Siri 和 Spotlight Suggestions 等产品都使用了这项技术。

什么是网络爬虫?简单的说就是一个用来自动浏览互联网的机器人,主要用来编制网络索引。爬虫可以保存自己访问过的页面,以便搜索引擎生成索引供用户搜索。

苹果的网络爬虫最早出现在2015年,当时网站管理员看到了一个IP地址为17的网络爬虫,这个IP地址块是苹果的。

随后,Apple 承认它正在使用网络爬虫。

知名 iOS 开发者 Benjamin Mayo 表示 Applebot 是由 Go 语言开发的。在 iOS 9 发布之前,Applebot 完全依赖于苹果办公室的四台 Mac Pro,这四台电脑每天可以爬行接近 10 亿。网页。

有趣的是,在 Applebot 推出的第一周,它几乎断开了 Apple 内部 DNS 服务器的连接。好在修改了自己的DNS解析和缓存,缓解了压力。

问题是,Siri 主要使用 Bing 和 Wolfram Alpha 进行网页搜索,那么为什么 Apple 需要自己为网页编制索引?

外媒 9to5mac 认为 Applebot 是一种补充现有第三方搜索引擎的工具,以确保 Siri 和 Spotlight 能够提供最佳搜索结果。

网页小说抓取 ios(哔咔漫画官网隐藏入口在哪呢?漫画达人重现探讨)

网站优化 • 优采云 发表了文章 • 0 个评论 • 102 次浏览 • 2022-01-01 05:07

碧卡aCG版官网ios隐藏入口怎么进入 碧卡aCG版picacomic官网ios隐藏入口怎么进入。 Bika Manga作为一款资源非常丰富的漫画阅读软件,深受大家的喜爱,可以轻松帮你摆脱困境。但是,Bika Comics中有很多漫画资源需要输入。只能看特殊模式,那么美嘉漫画官网的隐藏入口在哪里呢?下面是Bika漫画官网隐藏入口的分享。有兴趣的朋友可以过来看看!

Bica acg 版本的特点

1、[新的外观和感觉]

你找到的漫画资源都超级清晰,让你看到独特的画质。看漫画一定要清楚,各种细节要一目了然;

2、[超全漫画]

Bica acg版本每天都在升级,最新最火的漫画资源也关注其他网址,让你第一时间关注漫画,不落后于他人;

3、[离线缓存]

里面的漫画资源可以免费下载,让你尽享这一切,阅读的时候会提前缓存,不用担心卡顿。

Bika acg 版本亮点

1、Beep acg版本种类繁多,坚持每日升级,简单实用;

2、BEKA acg版所有内容均可离线下载本地查看;

3、采集功能,查看您采集的漫画,下载的漫画会自动采集;

4、页面美观大方,使用方便,分类齐全,每日更新,绅士必备。

贝卡acg版的优点

1、漫画大师再次讨论交流,共同参与互动分享;

2、超值人气漫画内容免费观看,实时在线升级阅读;

3、哔哔caracg版根据搜索习惯推送个性化消息,实时抓取需要的漫画;

4、会员区日常任务多样,寻找不同维度的组织,享受奢华福利。

Bika acg 版评测 Bika acg 版是一款非常优质的免费阅读漫画全文的手机应用。动漫迷可以根据作品关键词的输入或公司的拆分,轻松检索到自己喜欢的漫画资源。并且您需要能够在应用程序的 Bika acg 版本中留下您的评论,以分享您对作品或创作者的独特看法。有需要的小伙伴们赶快免费下载安装BEKAacg版应用吧。 查看全部

网页小说抓取 ios(哔咔漫画官网隐藏入口在哪呢?漫画达人重现探讨)

碧卡aCG版官网ios隐藏入口怎么进入 碧卡aCG版picacomic官网ios隐藏入口怎么进入。 Bika Manga作为一款资源非常丰富的漫画阅读软件,深受大家的喜爱,可以轻松帮你摆脱困境。但是,Bika Comics中有很多漫画资源需要输入。只能看特殊模式,那么美嘉漫画官网的隐藏入口在哪里呢?下面是Bika漫画官网隐藏入口的分享。有兴趣的朋友可以过来看看!

Bica acg 版本的特点

1、[新的外观和感觉]

你找到的漫画资源都超级清晰,让你看到独特的画质。看漫画一定要清楚,各种细节要一目了然;

2、[超全漫画]

Bica acg版本每天都在升级,最新最火的漫画资源也关注其他网址,让你第一时间关注漫画,不落后于他人;

3、[离线缓存]

里面的漫画资源可以免费下载,让你尽享这一切,阅读的时候会提前缓存,不用担心卡顿。

Bika acg 版本亮点

1、Beep acg版本种类繁多,坚持每日升级,简单实用;

2、BEKA acg版所有内容均可离线下载本地查看;

3、采集功能,查看您采集的漫画,下载的漫画会自动采集;

4、页面美观大方,使用方便,分类齐全,每日更新,绅士必备。

贝卡acg版的优点

1、漫画大师再次讨论交流,共同参与互动分享;

2、超值人气漫画内容免费观看,实时在线升级阅读;

3、哔哔caracg版根据搜索习惯推送个性化消息,实时抓取需要的漫画;

4、会员区日常任务多样,寻找不同维度的组织,享受奢华福利。

Bika acg 版评测 Bika acg 版是一款非常优质的免费阅读漫画全文的手机应用。动漫迷可以根据作品关键词的输入或公司的拆分,轻松检索到自己喜欢的漫画资源。并且您需要能够在应用程序的 Bika acg 版本中留下您的评论,以分享您对作品或创作者的独特看法。有需要的小伙伴们赶快免费下载安装BEKAacg版应用吧。

网页小说抓取 ios(如何在网上免费下载小说的软件--网络书籍器)

网站优化 • 优采云 发表了文章 • 0 个评论 • 119 次浏览 • 2021-12-22 22:03

回想起来,很多朋友都喜欢看武侠小说。编者还记得,当时我们捧着一本厚厚的武侠小说,津津有味地看书,似乎比高考还要严肃。尤其是近年来,各种玄幻小说层出不穷。虽然质量有好有坏,但也有很多非常好的小说,值得闲暇之余一读。随着人们版权意识的提高,我们的很多小说都可以付费阅读。虽然我们不支持阅读盗版小说,但对于很多学生党来说,阅读正版小说的成本是不菲的。章节才几毛钱,但是如果数量太多,一部几千章的小说,那我们学生党就撑不住了。今天,小编为大家带来一款可以在网上免费下载小说的软件——网络图书抓取器。本软件主要用于抓取网络小说生成的文本文件。它可以提取和调整指定小说目录页的章节信息,然后按照章节顺序抓取小说内容,然后进行合并。并且爬取过程可以随时中断,关闭程序后可以继续上一个任务,不用担心突然出错的原因。这次小编带来了绿色版的在线抢书器。欢迎有需要的朋友到本站免费下载体验!~ 它可以提取和调整指定小说目录页的章节信息,然后按照章节顺序抓取小说内容,然后进行合并。并且爬取过程可以随时中断,关闭程序后可以继续上一个任务,不用担心突然出错的原因。这次小编带来了绿色版的在线抢书器。欢迎有需要的朋友到本站免费下载体验!~ 它可以提取和调整指定小说目录页的章节信息,然后按照章节顺序抓取小说内容,然后进行合并。并且爬取过程可以随时中断,关闭程序后可以继续上一个任务,不用担心突然出错的原因。这次小编带来了绿色版的在线抢书器。欢迎有需要的朋友到本站免费下载体验!~ 这次小编带来了绿色版的在线抢书器。欢迎有需要的朋友到本站免费下载体验!~ 这次小编带来了绿色版的在线抢书器。欢迎有需要的朋友到本站免费下载体验!~

使用方法 1、 点击本站下载解压。

2、 单击应用程序将其打开。

3、进入要下载小说的网页,输入书名,点击目录解压。

4、设置保存路径,点击Start crawling开始下载。

特点1、章节调整

在线图书抓取器提取目录后,您可以进行移动、删除、倒序等调整操作。调整会直接影响最终的书籍,也会以调整后的章节顺序输出。

2、自动重试

在爬取过程中,由于网络因素,可能会出现爬取失败的情况。程序可能会自动重试直到成功,也可以暂时中断爬取(中断后关闭程序不影响进度),待网络良好后再试。

3、停止并继续

爬取过程可以随时停止,退出程序后不影响进度(章节信息会保存在记录中,下次运行程序后可以继续爬取。注意:需要停止先按停止键退出程序,直接退出将无法恢复)。

4、一键抓拍

又称“傻瓜模式”,基本可以实现全自动抓取合并的功能,直接输出最终的文本文件。前面可能需要输入最基本的网址、保存位置等信息(会有明显的操作提示),调整章节后也可以使用一键抓取,抓取合并操作会自动完成.

5、适用网站

10个适用的网站已经输入(选择后可以快速打开网站找到你需要的书),也可以自动应用相应的代码,其他小说网站都可以也进行了测试,如果组合使用,可以手动添加到配置文件中以备后用。

6、轻松制作电子书

设置文件中可以添加每个章节名称的前缀和后缀,为后期制作电子书的目录布局带来极大的方便。更新日志1、优化界面体验。

2、修复了一些已知的错误。 查看全部

网页小说抓取 ios(如何在网上免费下载小说的软件--网络书籍器)

回想起来,很多朋友都喜欢看武侠小说。编者还记得,当时我们捧着一本厚厚的武侠小说,津津有味地看书,似乎比高考还要严肃。尤其是近年来,各种玄幻小说层出不穷。虽然质量有好有坏,但也有很多非常好的小说,值得闲暇之余一读。随着人们版权意识的提高,我们的很多小说都可以付费阅读。虽然我们不支持阅读盗版小说,但对于很多学生党来说,阅读正版小说的成本是不菲的。章节才几毛钱,但是如果数量太多,一部几千章的小说,那我们学生党就撑不住了。今天,小编为大家带来一款可以在网上免费下载小说的软件——网络图书抓取器。本软件主要用于抓取网络小说生成的文本文件。它可以提取和调整指定小说目录页的章节信息,然后按照章节顺序抓取小说内容,然后进行合并。并且爬取过程可以随时中断,关闭程序后可以继续上一个任务,不用担心突然出错的原因。这次小编带来了绿色版的在线抢书器。欢迎有需要的朋友到本站免费下载体验!~ 它可以提取和调整指定小说目录页的章节信息,然后按照章节顺序抓取小说内容,然后进行合并。并且爬取过程可以随时中断,关闭程序后可以继续上一个任务,不用担心突然出错的原因。这次小编带来了绿色版的在线抢书器。欢迎有需要的朋友到本站免费下载体验!~ 它可以提取和调整指定小说目录页的章节信息,然后按照章节顺序抓取小说内容,然后进行合并。并且爬取过程可以随时中断,关闭程序后可以继续上一个任务,不用担心突然出错的原因。这次小编带来了绿色版的在线抢书器。欢迎有需要的朋友到本站免费下载体验!~ 这次小编带来了绿色版的在线抢书器。欢迎有需要的朋友到本站免费下载体验!~ 这次小编带来了绿色版的在线抢书器。欢迎有需要的朋友到本站免费下载体验!~

使用方法 1、 点击本站下载解压。

2、 单击应用程序将其打开。

3、进入要下载小说的网页,输入书名,点击目录解压。

4、设置保存路径,点击Start crawling开始下载。

特点1、章节调整

在线图书抓取器提取目录后,您可以进行移动、删除、倒序等调整操作。调整会直接影响最终的书籍,也会以调整后的章节顺序输出。

2、自动重试

在爬取过程中,由于网络因素,可能会出现爬取失败的情况。程序可能会自动重试直到成功,也可以暂时中断爬取(中断后关闭程序不影响进度),待网络良好后再试。

3、停止并继续

爬取过程可以随时停止,退出程序后不影响进度(章节信息会保存在记录中,下次运行程序后可以继续爬取。注意:需要停止先按停止键退出程序,直接退出将无法恢复)。

4、一键抓拍

又称“傻瓜模式”,基本可以实现全自动抓取合并的功能,直接输出最终的文本文件。前面可能需要输入最基本的网址、保存位置等信息(会有明显的操作提示),调整章节后也可以使用一键抓取,抓取合并操作会自动完成.

5、适用网站

10个适用的网站已经输入(选择后可以快速打开网站找到你需要的书),也可以自动应用相应的代码,其他小说网站都可以也进行了测试,如果组合使用,可以手动添加到配置文件中以备后用。

6、轻松制作电子书

设置文件中可以添加每个章节名称的前缀和后缀,为后期制作电子书的目录布局带来极大的方便。更新日志1、优化界面体验。

2、修复了一些已知的错误。

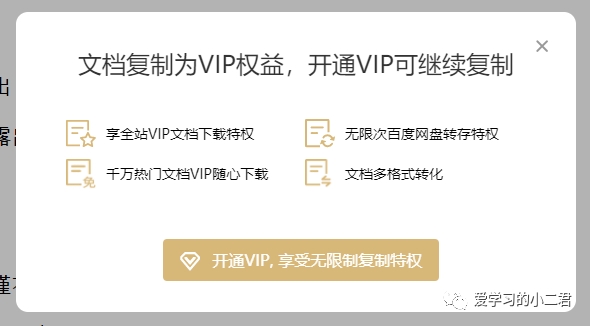

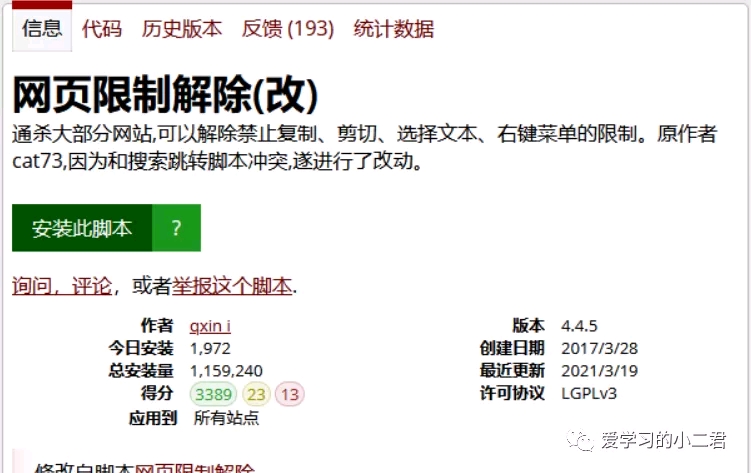

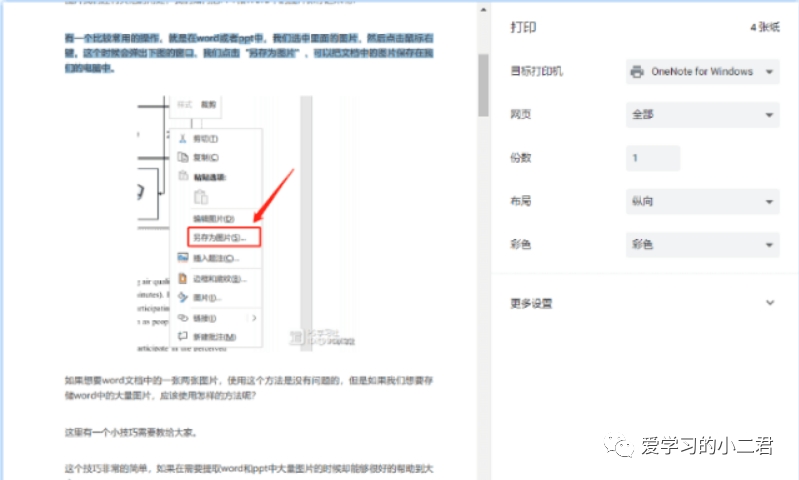

网页小说抓取 ios(轻松解除网页复制限制,一键搞定(简单实用)(图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 146 次浏览 • 2021-12-11 10:16

我们在浏览网页、搜索信息时,总是需要复制一些文字内容,用于引用、采集、摘录等。

但是网站上的部分内容和文字无法复制,或者右键菜单无法使用?!一般网站都有自己的禁止复制限制,右键菜单是禁用的。

很难找到的材料打出来太低效了……

五种分享方式,教你轻松解除网页复制限制,一键搞定,简单实用!

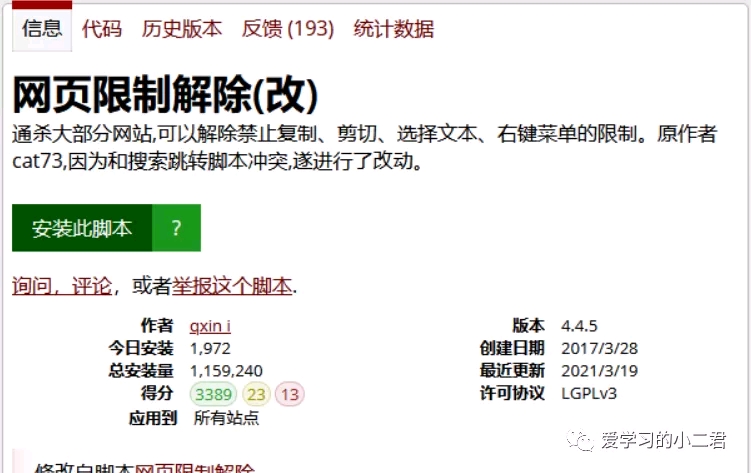

[总结] 解除网页文字复制限制的五种方法。方法一:浏览器扩展方法二:解除油猴脚本网页限制

与扩展效果一样,油猴脚本的优点是重量更轻。可以解除对禁止复制、文本选择和右键菜单的限制。

首先确保浏览器已安装脚本管理扩展,如Tampermonkey、Violentmonkey。如果您还没有安装,请到官网进行安装。

然后输入脚本地址,点击安装。

方法三:OCR识别

这可以说是最终的,肯定可行的方法。截图,然后通过OCR在线识别。

推荐使用线描网页版,免费使用,无需安装额外软件。

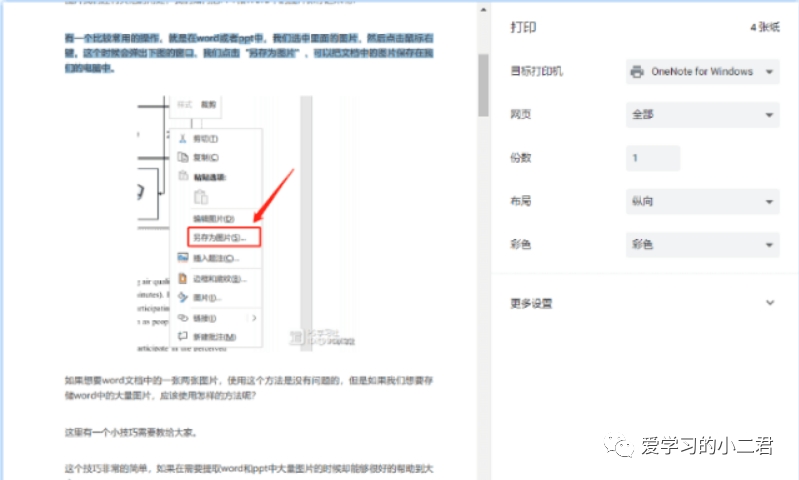

方法四:打印

快捷键Ctrl+P,或者Menu->Print,打印预览页面没有复印限制。

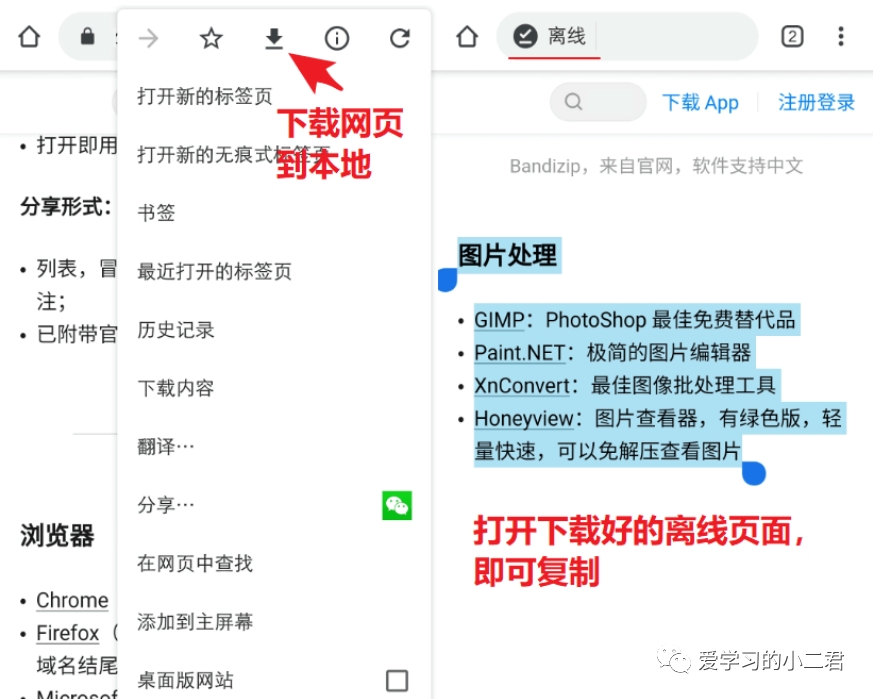

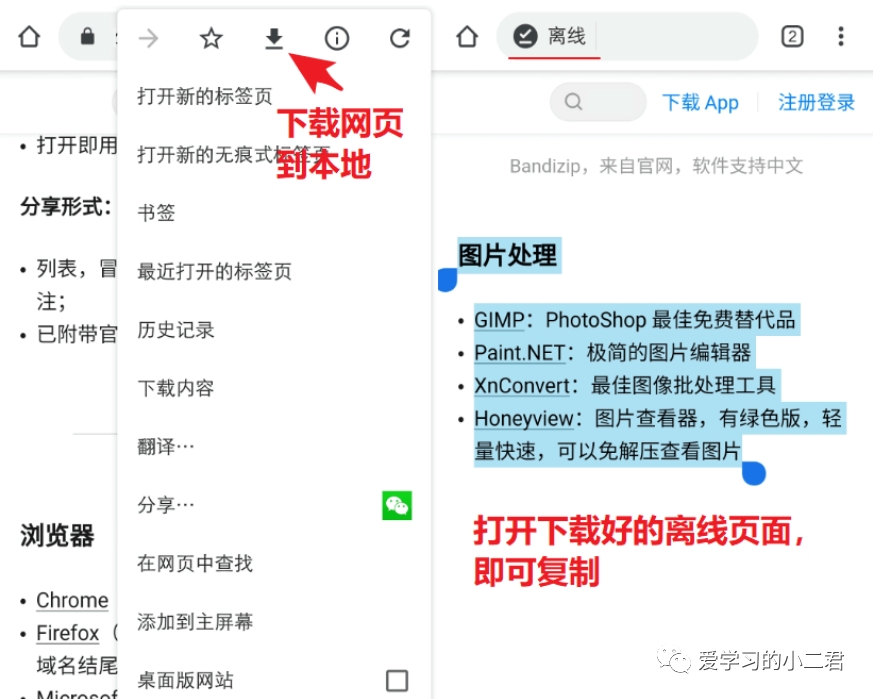

方法五:网页下载到本地

这种方法比较简单粗暴,手机上也可以用。

点击浏览器菜单,将网页下载到本地,然后打开离线版页面,直接复制即可~

当然,这也可以在电脑上完成。

另存网页为->另存为“网页,仅HTML”,也可以打开后直接复制。

结束语

以上五种解除网页复制限制的方法都不错,基本可以解决大部分网站的复制和右键限制。

还有更多F12开发者模式,查看网页源码等,就不一一介绍了。

当然,最好的效果是“金钱能力”。[总督] 查看全部

网页小说抓取 ios(轻松解除网页复制限制,一键搞定(简单实用)(图))

我们在浏览网页、搜索信息时,总是需要复制一些文字内容,用于引用、采集、摘录等。

但是网站上的部分内容和文字无法复制,或者右键菜单无法使用?!一般网站都有自己的禁止复制限制,右键菜单是禁用的。

很难找到的材料打出来太低效了……

五种分享方式,教你轻松解除网页复制限制,一键搞定,简单实用!

[总结] 解除网页文字复制限制的五种方法。方法一:浏览器扩展方法二:解除油猴脚本网页限制

与扩展效果一样,油猴脚本的优点是重量更轻。可以解除对禁止复制、文本选择和右键菜单的限制。

首先确保浏览器已安装脚本管理扩展,如Tampermonkey、Violentmonkey。如果您还没有安装,请到官网进行安装。

然后输入脚本地址,点击安装。

方法三:OCR识别

这可以说是最终的,肯定可行的方法。截图,然后通过OCR在线识别。

推荐使用线描网页版,免费使用,无需安装额外软件。

方法四:打印

快捷键Ctrl+P,或者Menu->Print,打印预览页面没有复印限制。

方法五:网页下载到本地

这种方法比较简单粗暴,手机上也可以用。

点击浏览器菜单,将网页下载到本地,然后打开离线版页面,直接复制即可~

当然,这也可以在电脑上完成。

另存网页为->另存为“网页,仅HTML”,也可以打开后直接复制。

结束语

以上五种解除网页复制限制的方法都不错,基本可以解决大部分网站的复制和右键限制。

还有更多F12开发者模式,查看网页源码等,就不一一介绍了。

当然,最好的效果是“金钱能力”。[总督]

网页小说抓取 ios(能通过小说网站的html网页源代码,分析关键信息的规则 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 112 次浏览 • 2021-12-02 03:08

)

小说规则捕捉器可以通过小说网站的html网页源码分析关键信息的规则来抓取书籍,最终输出抓取的书籍(支持txt、ePub、zip格式输出)。

相关软件软件大小版本说明下载地址

小说规则捕捉器可以通过小说网站的html网页源码分析关键信息的规则来抓取书籍,最终输出抓取的书籍(支持txt、ePub、zip格式输出)。

软件介绍

这个软件可以说是好用,也可以说是难用。比如直接从网站中抓取书籍,直接从自带的100多个预设网站中抓取(需要浏览搜索你要下载的书籍,然后复制链接到入口URL),无需分析复杂的源代码。对于逻辑思维能力强的用户,可以分析小说网站的源码,制定网站的捕捉规则,基本可以应对大部分小说网站。

软件特点

自定义规则抓取,可以抓取大部分小说网络文章,个别网站对图书进行详细分类,支持多书抓取;

自带大量预测网站,没有定义规则的用户可以直接申请,也可以抓取自己需要的小说;

内置源码查看器,提供链接分析、关键定位、标签分割等工具;

对于大型小说,任务暂存到数据库后,可以随意中断和恢复任务;

图书提供多种输出方式:章节文件、独立文本文件、压缩包、ePub电子书等;

支持任务导入,即从文本文件和excel文档中导入任务,带章节页面链接进行抓取;

所有组件都支持提示信息,即光标停止后会显示相关提示。大部分操作支持状态栏提示,使用更方便;

支持添加、修改、导入、导出、排序和删除预设网站;

附赠小工具:ePub电子书制作与分解工具,支持从章节存储的书籍中生成ePub文件,也可以将ePub文件分解为多章节的文本文件。

查看全部

网页小说抓取 ios(能通过小说网站的html网页源代码,分析关键信息的规则

)

小说规则捕捉器可以通过小说网站的html网页源码分析关键信息的规则来抓取书籍,最终输出抓取的书籍(支持txt、ePub、zip格式输出)。

相关软件软件大小版本说明下载地址

小说规则捕捉器可以通过小说网站的html网页源码分析关键信息的规则来抓取书籍,最终输出抓取的书籍(支持txt、ePub、zip格式输出)。

软件介绍

这个软件可以说是好用,也可以说是难用。比如直接从网站中抓取书籍,直接从自带的100多个预设网站中抓取(需要浏览搜索你要下载的书籍,然后复制链接到入口URL),无需分析复杂的源代码。对于逻辑思维能力强的用户,可以分析小说网站的源码,制定网站的捕捉规则,基本可以应对大部分小说网站。

软件特点

自定义规则抓取,可以抓取大部分小说网络文章,个别网站对图书进行详细分类,支持多书抓取;

自带大量预测网站,没有定义规则的用户可以直接申请,也可以抓取自己需要的小说;

内置源码查看器,提供链接分析、关键定位、标签分割等工具;

对于大型小说,任务暂存到数据库后,可以随意中断和恢复任务;

图书提供多种输出方式:章节文件、独立文本文件、压缩包、ePub电子书等;

支持任务导入,即从文本文件和excel文档中导入任务,带章节页面链接进行抓取;

所有组件都支持提示信息,即光标停止后会显示相关提示。大部分操作支持状态栏提示,使用更方便;

支持添加、修改、导入、导出、排序和删除预设网站;

附赠小工具:ePub电子书制作与分解工具,支持从章节存储的书籍中生成ePub文件,也可以将ePub文件分解为多章节的文本文件。

网页小说抓取 ios(爬虫脚本项目设置本地脚本创建app,部署开发环境)

网站优化 • 优采云 发表了文章 • 0 个评论 • 95 次浏览 • 2021-11-22 12:12

爬虫脚本

项目地址:

需要:python 2.7

原理:利用urllib2下载页面,然后正则匹配内容,将抓取的内容生成index.html

#novel_spider.py

设置github网页

蜘蛛项目设置github页面,小说网页托管在github上

服务器定时生成页面

需要:服务器 or 一台一直开着的机器

将git上的代码迁出到服务器

#crontab设置

crontab -e

#每小时的第30分钟拉取一次页面数据

10 * * * * ./home/jinxiu/code/spider/gen.sh >> /home/jinxiu/log/spider.log

#设置crontab开机启动

systemctl status crond.service #查看crontab服务状态

systemctl enable crond.service #开机自启动

#gen.sh

pwd=`dirname $0`

cd $pwd

git pull origin master

./novel_spider.py

git commit -a -m "gen index html"

git push origin

创建应用

这里使用apicloud创建app,主要是为了方便,没有部署android开发环境。

项目地址:

apicloud页面选择创建本地项目,生成的代码地址用svn工具签出

#修改config.html, 设置app自动更新

#修改index.html

apiready = function(){

//输出Log,Log将显示在APICloud Studio控制台

console.log("Hello APICloud");

api.openFrame({

name: 'main',

url: 'https://specialtiger.github.io/spider/',

// url: 'https://www.baidu.com',

bounces: true,

rect: {

x: 0,

y: 0,

w: 'auto',

h: 'auto'

}

});

};

由于没有下载Android Studio(虽然后来下载了,上墙用这个有点痛苦),看了好多种app生成方式,最终决定使用apicloud云编译。该平台无需在本地设置环境即可创建应用程序! (本来想用python做android的,结果发现这个产品又坑了。)

最重要的是apicloud有一套在线编译发布系统,可以生成apk下载链接,自动更新已安装的应用。可以用他的sdk用wifi模拟器调试,从头到尾调试不需要usb连接,也不需要手机。

前提是学习一点html编程的基础知识。 app原理由本地web框架生成。所以看小说就够了。如果您需要快速创建网络应用,可以考虑。 查看全部

网页小说抓取 ios(爬虫脚本项目设置本地脚本创建app,部署开发环境)

爬虫脚本

项目地址:

需要:python 2.7

原理:利用urllib2下载页面,然后正则匹配内容,将抓取的内容生成index.html

#novel_spider.py

设置github网页

蜘蛛项目设置github页面,小说网页托管在github上

服务器定时生成页面

需要:服务器 or 一台一直开着的机器

将git上的代码迁出到服务器

#crontab设置

crontab -e

#每小时的第30分钟拉取一次页面数据

10 * * * * ./home/jinxiu/code/spider/gen.sh >> /home/jinxiu/log/spider.log

#设置crontab开机启动

systemctl status crond.service #查看crontab服务状态

systemctl enable crond.service #开机自启动

#gen.sh

pwd=`dirname $0`

cd $pwd

git pull origin master

./novel_spider.py

git commit -a -m "gen index html"

git push origin

创建应用

这里使用apicloud创建app,主要是为了方便,没有部署android开发环境。

项目地址:

apicloud页面选择创建本地项目,生成的代码地址用svn工具签出

#修改config.html, 设置app自动更新

#修改index.html

apiready = function(){

//输出Log,Log将显示在APICloud Studio控制台

console.log("Hello APICloud");

api.openFrame({

name: 'main',

url: 'https://specialtiger.github.io/spider/',

// url: 'https://www.baidu.com',

bounces: true,

rect: {

x: 0,

y: 0,

w: 'auto',

h: 'auto'

}

});

};

由于没有下载Android Studio(虽然后来下载了,上墙用这个有点痛苦),看了好多种app生成方式,最终决定使用apicloud云编译。该平台无需在本地设置环境即可创建应用程序! (本来想用python做android的,结果发现这个产品又坑了。)

最重要的是apicloud有一套在线编译发布系统,可以生成apk下载链接,自动更新已安装的应用。可以用他的sdk用wifi模拟器调试,从头到尾调试不需要usb连接,也不需要手机。

前提是学习一点html编程的基础知识。 app原理由本地web框架生成。所以看小说就够了。如果您需要快速创建网络应用,可以考虑。

网页小说抓取 ios(小说阅读器测评小说读者应用程序下载地址及用户快来下载)

网站优化 • 优采云 发表了文章 • 0 个评论 • 154 次浏览 • 2021-11-18 17:21

小说阅读器是很多用户非常喜欢的一款工具软件。有很多最新的内容可以体验。小说阅读器内容丰富,各种网络小说都可以在这里体验。就是这样,有需要的用户快来下载吧。

小说阅读器简介

1. 超级简单的手机免费阅读工具,内容丰富的在线图书资源;

2.这些都是为用户挑选的小说,主题分类非常详细,方便你;

3.找书流畅阅读,支持模拟翻页、夜读等模式,阅读舒适;

4.网上很多优质小说,网络小说都在,也都会在;

5. 简单小说随心所欲,放心看小说,让你在线看更多小说。

小说阅读器的特点

让您看到更多有趣的小说,在线快速搜索大型小说,选择网络上更热门的网络小说,提供最新的浏览服务;

小说阅读器是一款不错的手机,可以免费看小说工具,在线搜索所有主题的新资源。你喜欢看小说;

不要错过,支持全缓存,还可以选择自己喜欢的小说,一切免费,喜欢看小说搜索下载。

小说读者评价

小说阅读器应用是海量资源和便捷的移动免费阅读工具,在线拥有者拥有多种小说资源;

喜欢阅读本书的用户不会错过,用户支持小说全缓存,更多主题和本书更新。 查看全部

网页小说抓取 ios(小说阅读器测评小说读者应用程序下载地址及用户快来下载)

小说阅读器是很多用户非常喜欢的一款工具软件。有很多最新的内容可以体验。小说阅读器内容丰富,各种网络小说都可以在这里体验。就是这样,有需要的用户快来下载吧。

小说阅读器简介

1. 超级简单的手机免费阅读工具,内容丰富的在线图书资源;

2.这些都是为用户挑选的小说,主题分类非常详细,方便你;

3.找书流畅阅读,支持模拟翻页、夜读等模式,阅读舒适;

4.网上很多优质小说,网络小说都在,也都会在;

5. 简单小说随心所欲,放心看小说,让你在线看更多小说。

小说阅读器的特点

让您看到更多有趣的小说,在线快速搜索大型小说,选择网络上更热门的网络小说,提供最新的浏览服务;

小说阅读器是一款不错的手机,可以免费看小说工具,在线搜索所有主题的新资源。你喜欢看小说;

不要错过,支持全缓存,还可以选择自己喜欢的小说,一切免费,喜欢看小说搜索下载。

小说读者评价

小说阅读器应用是海量资源和便捷的移动免费阅读工具,在线拥有者拥有多种小说资源;

喜欢阅读本书的用户不会错过,用户支持小说全缓存,更多主题和本书更新。

网页小说抓取 ios(iOS网络编程获取网页的HTML源代码数据:数据)

网站优化 • 优采云 发表了文章 • 0 个评论 • 98 次浏览 • 2021-11-16 01:12

在我之前的博客《iOS项目开发实战——iOS网络编程获取网页Html源代码》中介绍了如何获取网页的HTML源代码,可以满足一定的需求。但是由于特殊原因,我们想要获取的是网页的二进制数据,那么我们该怎么做呢?

具体实现如下:

(1) 创建一个iOS项目,Language选择Swift,然后在ViewController.swift中编写如下代码:

override func viewDidLoad() {

super.viewDidLoad()

var data = NSData(contentsOfURL: NSURL(string: "http://www.baidu.com")!)

println(data!)

}

(2)运行程序,结果如下,可以成功获取网页的二进制数据:

.

(3)现在优化返回可能为空的情况,优化代码如下:

override func viewDidLoad() {

super.viewDidLoad()

var data = NSData(contentsOfURL: NSURL(string: "fdsvsdfgvdf")!)

if let binarydata = data{

println(data!)

}else{

println("未能获取网络数据")

}

}

此时的输出结果是“获取网络数据失败”。防止网络请求失败时系统崩溃。

github主页:. 欢迎大家光临! 查看全部

网页小说抓取 ios(iOS网络编程获取网页的HTML源代码数据:数据)

在我之前的博客《iOS项目开发实战——iOS网络编程获取网页Html源代码》中介绍了如何获取网页的HTML源代码,可以满足一定的需求。但是由于特殊原因,我们想要获取的是网页的二进制数据,那么我们该怎么做呢?

具体实现如下:

(1) 创建一个iOS项目,Language选择Swift,然后在ViewController.swift中编写如下代码:

override func viewDidLoad() {

super.viewDidLoad()

var data = NSData(contentsOfURL: NSURL(string: "http://www.baidu.com";)!)

println(data!)

}

(2)运行程序,结果如下,可以成功获取网页的二进制数据:

.

(3)现在优化返回可能为空的情况,优化代码如下:

override func viewDidLoad() {

super.viewDidLoad()

var data = NSData(contentsOfURL: NSURL(string: "fdsvsdfgvdf")!)

if let binarydata = data{

println(data!)

}else{

println("未能获取网络数据")

}

}

此时的输出结果是“获取网络数据失败”。防止网络请求失败时系统崩溃。

github主页:. 欢迎大家光临!

小鬼快搜去广告版,漫画、小说一网打尽

网站优化 • 优采云 发表了文章 • 0 个评论 • 88 次浏览 • 2022-05-23 21:44

喜欢看小说、漫画的伙伴日常在网页端食用时看着满屏的弹窗广告心中一定一团怒火。即使选择客户端食用时很多APP上也免不了软件内嵌的广告,甚至以会员形式来收费去除广告。

小鬼快搜,很好的解决工具之一。

囊括了海量的免费优质资源,再加上聚合各大搜索引擎可全方面搜索想要的内容,配合软件自带的网页嗅探,净化网页去广告,捕获下载源,自动分集分章节等诸多贴心功能能够带来绝佳的浏览体验。

因为资源全是来源于网络搜索爬取所以也不用太考虑资源以及软件失效等问题,除了悲催到断网否则能一直用下去。目前有小说、漫画、TXT三个板块,效果还不错全部都是免费提供的。

如果有一天发现收费无法享用时,那一定是嗅探到的资源变成收费了,不是软件起的猫腻。

软件自身没有任何广告,非常的纯净!

软件介绍:

小说

小鬼快搜的小说版块和TXT版块一直让橘子疑惑:都是看书籍的功能为啥要分两个版块,而且两个版块搜索展现的内容都不一样。原来有一个搜索文学读物比较给力,另一个网络小说比较齐全。

如果没有搜索到想要的书籍可以试试换源、全网搜索,然后就会跳转到各大搜索引擎搜索,此时与大家用浏览器搜索内容基本一致,但是软件贴心的地方就来了。

能够一键嗅探是否有相关资源的网页,一键净化原网页的广告并自动转换为软件内阅读器上阅读,此时你会发现章节都为之整理好了。对于喜欢在网页看小说的小伙伴不妨试试这个功能确实挺赞的。

净化前后对比

漫画

漫画功能丝毫不含糊,老规矩搜索展现大量的网络内容,没找到依旧是全网搜索净化页面,转换到软件内的阅读器上阅读,再也不受各种横幅广告的影响。

在阅读时发现章节缺少或者体验不佳可以在底部点击换源,另外还可以直接离线下载至手机本地方便下次快速观看。无论是看小说还是追漫画,都可以加入收藏方便下次打开避免重新找资源的窘境。

净化前后对比

破解说明:

去除广告

说明:小鬼快搜将在今后更换服务器并迁移相关数据,待服务器稳定后旧版本可能就无法继续使用。不过伙伴们放心,如有变化,同步更新分享。

比较遗憾,小鬼快搜没有iOS版。唯一美中不足的就是旧版本中加入了影视板块,在此板中却给剔除了。

软件自身不存储任何资源,完全是依赖于网络搜索抓取,因此容易受一些网页中不安全因素影响,作为科学合理使用还是一款不可多得的应用。

往期精品软件

安装包:

公众号后台发送:424 查看全部

小鬼快搜去广告版,漫画、小说一网打尽

喜欢看小说、漫画的伙伴日常在网页端食用时看着满屏的弹窗广告心中一定一团怒火。即使选择客户端食用时很多APP上也免不了软件内嵌的广告,甚至以会员形式来收费去除广告。

小鬼快搜,很好的解决工具之一。

囊括了海量的免费优质资源,再加上聚合各大搜索引擎可全方面搜索想要的内容,配合软件自带的网页嗅探,净化网页去广告,捕获下载源,自动分集分章节等诸多贴心功能能够带来绝佳的浏览体验。

因为资源全是来源于网络搜索爬取所以也不用太考虑资源以及软件失效等问题,除了悲催到断网否则能一直用下去。目前有小说、漫画、TXT三个板块,效果还不错全部都是免费提供的。

如果有一天发现收费无法享用时,那一定是嗅探到的资源变成收费了,不是软件起的猫腻。

软件自身没有任何广告,非常的纯净!

软件介绍:

小说

小鬼快搜的小说版块和TXT版块一直让橘子疑惑:都是看书籍的功能为啥要分两个版块,而且两个版块搜索展现的内容都不一样。原来有一个搜索文学读物比较给力,另一个网络小说比较齐全。

如果没有搜索到想要的书籍可以试试换源、全网搜索,然后就会跳转到各大搜索引擎搜索,此时与大家用浏览器搜索内容基本一致,但是软件贴心的地方就来了。

能够一键嗅探是否有相关资源的网页,一键净化原网页的广告并自动转换为软件内阅读器上阅读,此时你会发现章节都为之整理好了。对于喜欢在网页看小说的小伙伴不妨试试这个功能确实挺赞的。

净化前后对比

漫画

漫画功能丝毫不含糊,老规矩搜索展现大量的网络内容,没找到依旧是全网搜索净化页面,转换到软件内的阅读器上阅读,再也不受各种横幅广告的影响。

在阅读时发现章节缺少或者体验不佳可以在底部点击换源,另外还可以直接离线下载至手机本地方便下次快速观看。无论是看小说还是追漫画,都可以加入收藏方便下次打开避免重新找资源的窘境。

净化前后对比

破解说明:

去除广告

说明:小鬼快搜将在今后更换服务器并迁移相关数据,待服务器稳定后旧版本可能就无法继续使用。不过伙伴们放心,如有变化,同步更新分享。

比较遗憾,小鬼快搜没有iOS版。唯一美中不足的就是旧版本中加入了影视板块,在此板中却给剔除了。

软件自身不存储任何资源,完全是依赖于网络搜索抓取,因此容易受一些网页中不安全因素影响,作为科学合理使用还是一款不可多得的应用。

往期精品软件

安装包:

公众号后台发送:424

网页小说抓取 ios(软件界面主界面任务管理系统设置+ePub制作)

网站优化 • 优采云 发表了文章 • 0 个评论 • 87 次浏览 • 2022-04-01 16:00

新颖的规则捕捉器是共享共享的,可以帮助用户分析相关代码,抓取目标网站的新颖资源,支持直接捕获,或者目标设置,在一定范围内筛选后捕获目标。针对性强,可以设置多个条件,让用户更快的找到自己想看的小说资源。

【软件特色】

自定义规则抓取,可以文章抓取大部分小说网,个别网站分类书籍详细分类,还支持多本抓取;

自带海量预测网站,不定义规则的用户可以直接套用,也可以抓取自己需要的小说;

自带源码查看器,提供链接分析、关键定位、标签分割等工具;

对于大型小说,任务暂存数据库后,可随意中断和恢复;

图书提供多种输出方式:章节文件、独立文本文件、压缩包、ePub电子书等;

支持任务导入,即从文本文件和带有章节页面链接的excel文档中导入任务进行抓取;

所有组件都支持提示信息,即光标停止后会显示相关提示,大部分操作都支持状态栏提示,使用更方便;

支持添加、修改、导入、导出、排序、删除预设网站;

【功能介绍】

本软件可以通过小说网站的html网页源码抓书,分析关键信息的规律,最终输出抓书(支持txt、ePub、zip格式输出)。

这个软件可以说好用也好难,比如简单的从网站抓书,直接从自带的100多个预设网站抓(需要浏览通过你可以用浏览器搜索你想下载的书,然后复制链接到入口网址),无需分析复杂的源码。对于逻辑思维能力强的用户,通过分析小说网站的源码,制定网站的抓包规则,基本可以应对大部分小说网站。

【工具特点】

ePub电子书制作分解工具,支持分章存储的书籍生成ePub文件,也可以将ePub文件分解成多章文本文件。

软件界面

主界面

任务管理

系统设置 + ePub 小部件

分析代码窗口

【更新日志】

修复已知问题并优化软件。 查看全部

网页小说抓取 ios(软件界面主界面任务管理系统设置+ePub制作)

新颖的规则捕捉器是共享共享的,可以帮助用户分析相关代码,抓取目标网站的新颖资源,支持直接捕获,或者目标设置,在一定范围内筛选后捕获目标。针对性强,可以设置多个条件,让用户更快的找到自己想看的小说资源。

【软件特色】

自定义规则抓取,可以文章抓取大部分小说网,个别网站分类书籍详细分类,还支持多本抓取;

自带海量预测网站,不定义规则的用户可以直接套用,也可以抓取自己需要的小说;

自带源码查看器,提供链接分析、关键定位、标签分割等工具;

对于大型小说,任务暂存数据库后,可随意中断和恢复;

图书提供多种输出方式:章节文件、独立文本文件、压缩包、ePub电子书等;

支持任务导入,即从文本文件和带有章节页面链接的excel文档中导入任务进行抓取;

所有组件都支持提示信息,即光标停止后会显示相关提示,大部分操作都支持状态栏提示,使用更方便;

支持添加、修改、导入、导出、排序、删除预设网站;

【功能介绍】

本软件可以通过小说网站的html网页源码抓书,分析关键信息的规律,最终输出抓书(支持txt、ePub、zip格式输出)。

这个软件可以说好用也好难,比如简单的从网站抓书,直接从自带的100多个预设网站抓(需要浏览通过你可以用浏览器搜索你想下载的书,然后复制链接到入口网址),无需分析复杂的源码。对于逻辑思维能力强的用户,通过分析小说网站的源码,制定网站的抓包规则,基本可以应对大部分小说网站。

【工具特点】

ePub电子书制作分解工具,支持分章存储的书籍生成ePub文件,也可以将ePub文件分解成多章文本文件。

软件界面

主界面

任务管理

系统设置 + ePub 小部件

分析代码窗口

【更新日志】

修复已知问题并优化软件。

网页小说抓取 ios( iOS14.2公测版beta1版描述文件在哪下载(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 112 次浏览 • 2022-03-29 14:20

iOS14.2公测版beta1版描述文件在哪下载(组图))

iOS14.2公测beta1描述文件下载地址 iOS14.2在哪里下载描述文件

9月22日,今天苹果正式发布了iOS14.2公测版的beta1版本,增加了一些小功能。很多朋友还不知道iOS14.2描述文件在哪里下载。下面就和大家分享一下吧。说明文件下载:iOS14/iPa

iOS13.6GM版本描述文件下载地址 iOS13.6GM版本描述文件在哪里下载

7月10日,苹果正式发布了iOS13.6GM版本,有小伙伴还不知道去哪里下载iOS13.6GM版本描述文件,跟大家分享一下iOS13.的6GM版本描述文件的下载地址。Apple 于 2020 年 7 月 10 日发布

iOS13.6Beta3开发者版本描述文件下载地址苹果ios13.6在哪里下载描述文件

苹果iOS13.6开发者预览版Beta3已经发布。该版本主要修复了一些bug,提升了性能。有的小伙伴还不知道去哪里下载iOS13.6开发者预览版Beta3的描述文件,下面为大家分解一下

iOS14.2公测版Beta3描述文件下载iOS14.2描述文件在哪里下载

2020年10月15日,今天苹果正式发布了iOS14.2公测Beta3版本,增加了一些小功能和表情,部分朋友还在寻找iOS14.2公测Beta3版本的描述文件,分享给大家。苹果在 iO

我怎样才能写出更好的 网站 描述?

网站的描述怎么写?首先说明他不会参与网站排名的计算,但是对于促进用户的刺激点击起到了很大的作用。如果 网站 描述写得好,很容易吸引用户的眼球并点击您的 网站。

16个如何写好应用描述的例子:不仅仅是把ASO做得好

应用描述很重要,很多人都知道,但是你有没有亲自比较和研究过其他人的应用是如何描述的?

如何提高 DSR 中婴儿描述的评分

在DSR动态评分越来越重要的今天,作为卖家,我们应该如何优化我们的产品描述,避免出错,提高评分呢?

iOS13.7开发版beta描述文件下载地址 iOS13.7开发版描述文件在哪里下载

2020 年 8 月 27 日,今天苹果再次推送 iOS13.7 的开发者预览 Beta 版,允许您选择加入 COVID-19 暴露通知系统并修复一些错误。下面给大家看分享这个iOS13.7开发者预览

iOS15描述文件下载地址 iOS15开发者测试版描述文件在哪里下载

苹果iOS15系列

iOS14beta4和iPadOS14描述文件下载地址自带详细安装教程

2020年8月5日,iOS14beta4正式推送更新。本次更新主要修复了一些bug,并没有特别大的更新内容。很多朋友还在找iOS14beta4的描述文件下载。让我和你分享这个。时代iOS14be

iOS9学习系列:打通iOS9的通用链接(UniversalLinks)

iOS9学习系列:打通iOS9的通用链接 2015-09-02 11:50 编辑:随玲 分类:iOS开发 来源:HOKO的博客04446iOS9通用链接:BreakingdowniOS9U

iOS14Beta5公测描述文件下载 iOS14Beta5描述文件在哪里下载

2020年8月20日,苹果推送iOS14公测版Beta5。这个版本有很多内容更新,其中最重要的就是修复了王者荣耀的登录和闪退bug。让我和你分享这个。第二次 iOS14 Public Beta Beta

网站如何优化如何设置描述?

描述是Head和整个网页SEO的第二个重要部分。虽然搜索引擎不将其设置为排名因素,但它可以引导搜索引擎找到他们需要的内容。那么,网站如何在优化中设置SEO中的描述(Description)呢?

网站写描述有什么意义?

今天笔者就来聊一聊网站描述的写法,帮助站长们了解如何写网站描述,既保证用户体验,又利于SEO。

元创:网站如何写出更好的描述

元创在推诊培训的时候,看到很多朋友网站的描述还是写错了。你可能遇到过他们。你要的信息是搜索引擎给你设置的描述不理想,所以抓取其他内容替换文章描述内容,今天元创就说描述如下 查看全部

网页小说抓取 ios(

iOS14.2公测版beta1版描述文件在哪下载(组图))

iOS14.2公测beta1描述文件下载地址 iOS14.2在哪里下载描述文件

9月22日,今天苹果正式发布了iOS14.2公测版的beta1版本,增加了一些小功能。很多朋友还不知道iOS14.2描述文件在哪里下载。下面就和大家分享一下吧。说明文件下载:iOS14/iPa

iOS13.6GM版本描述文件下载地址 iOS13.6GM版本描述文件在哪里下载

7月10日,苹果正式发布了iOS13.6GM版本,有小伙伴还不知道去哪里下载iOS13.6GM版本描述文件,跟大家分享一下iOS13.的6GM版本描述文件的下载地址。Apple 于 2020 年 7 月 10 日发布

iOS13.6Beta3开发者版本描述文件下载地址苹果ios13.6在哪里下载描述文件

苹果iOS13.6开发者预览版Beta3已经发布。该版本主要修复了一些bug,提升了性能。有的小伙伴还不知道去哪里下载iOS13.6开发者预览版Beta3的描述文件,下面为大家分解一下

iOS14.2公测版Beta3描述文件下载iOS14.2描述文件在哪里下载

2020年10月15日,今天苹果正式发布了iOS14.2公测Beta3版本,增加了一些小功能和表情,部分朋友还在寻找iOS14.2公测Beta3版本的描述文件,分享给大家。苹果在 iO

我怎样才能写出更好的 网站 描述?

网站的描述怎么写?首先说明他不会参与网站排名的计算,但是对于促进用户的刺激点击起到了很大的作用。如果 网站 描述写得好,很容易吸引用户的眼球并点击您的 网站。

16个如何写好应用描述的例子:不仅仅是把ASO做得好

应用描述很重要,很多人都知道,但是你有没有亲自比较和研究过其他人的应用是如何描述的?

如何提高 DSR 中婴儿描述的评分