智能采集组合文章

智能采集组合文章标题起好了,后期怎么去优化

采集交流 • 优采云 发表了文章 • 0 个评论 • 285 次浏览 • 2021-03-21 20:04

智能采集组合文章采集比如新浪采集然后就自动生成标题,标签。设置好关键词,连接等,用热度,排名,搜索量高的关键词,按照搜索页数,调整生成相对应的页面标题,标签。然后保存下来,

真正的做大新浪新闻采集,没有什么捷径,基本上,标题起好了,标签起好了,文章标题起好了,后期怎么去优化,

利用百度搜索引擎原创能力强大,不定期用账号来各大门户网站或者是自媒体网站发布新闻更换标题原文编辑同步即可现在互联网追求原创热点新闻,新闻热点可以大家看看今日头条,

最主要的还是写好标题,一般写的标题越短越好,可以加一个副标题。一个标题就是一个连接。

引导文章进入公众号直接发送关键词即可

百度已经不错了,再往下做就乏力了,其实多关注一些专业行业的网站,看看那些牛逼的比如云计算,可以大批量抓取。抓取后生成伪原创,然后优化。

如果新浪微博,论坛,贴吧等都没有帐号,或者帐号名字中带有一个新闻的字样,

根据目标用户人群进行关键词分析,记录好你觉得可以写出标题的词,先熟悉关键词的分布,可以整理成为excel表格,用access保存好,避免漏网之鱼。接下来是优化文章的标题,然后抓取相关关键词作为伪原创,从而做到文章的精细化,可以尝试垂直媒体,多盟写作平台,认证自媒体等,通过不断地修改文章,提高文章质量,提高原创度。推荐,我是艾市姿,从事新媒体营销12年,希望我的回答能够帮助到你。 查看全部

智能采集组合文章标题起好了,后期怎么去优化

智能采集组合文章采集比如新浪采集然后就自动生成标题,标签。设置好关键词,连接等,用热度,排名,搜索量高的关键词,按照搜索页数,调整生成相对应的页面标题,标签。然后保存下来,

真正的做大新浪新闻采集,没有什么捷径,基本上,标题起好了,标签起好了,文章标题起好了,后期怎么去优化,

利用百度搜索引擎原创能力强大,不定期用账号来各大门户网站或者是自媒体网站发布新闻更换标题原文编辑同步即可现在互联网追求原创热点新闻,新闻热点可以大家看看今日头条,

最主要的还是写好标题,一般写的标题越短越好,可以加一个副标题。一个标题就是一个连接。

引导文章进入公众号直接发送关键词即可

百度已经不错了,再往下做就乏力了,其实多关注一些专业行业的网站,看看那些牛逼的比如云计算,可以大批量抓取。抓取后生成伪原创,然后优化。

如果新浪微博,论坛,贴吧等都没有帐号,或者帐号名字中带有一个新闻的字样,

根据目标用户人群进行关键词分析,记录好你觉得可以写出标题的词,先熟悉关键词的分布,可以整理成为excel表格,用access保存好,避免漏网之鱼。接下来是优化文章的标题,然后抓取相关关键词作为伪原创,从而做到文章的精细化,可以尝试垂直媒体,多盟写作平台,认证自媒体等,通过不断地修改文章,提高文章质量,提高原创度。推荐,我是艾市姿,从事新媒体营销12年,希望我的回答能够帮助到你。

一款很不错的文章处理工具,可以进行素材采集

采集交流 • 优采云 发表了文章 • 0 个评论 • 282 次浏览 • 2021-03-20 22:05

AI 文章智能处理软件是一种智能的文章 伪原创工具,可以帮助用户重组文章以形成新的文章,并且还可以执行物料采集。一个非常好的文章处理工具。

功能介绍:

1、 Intelligent 伪原创:在人工智能中使用自然语言处理技术来实现文章 伪原创处理。核心功能包括“智能伪原创”,“同义词替换伪原创”,“反义词替换伪原创”,“使用html代码在文章中随机插入关键词”,“句子改组和重组”等等等,处理后的文章 原创度和收录比率均高于80%。想了解更多功能,请下载软件进行试用。

2、门户文章 采集:一键式搜索集合相关门户网站新闻文章,网站搜狐,腾讯,新浪,网易,头条。 com,,联合早报,光明网,网站管理员网,新文化网等,用户可以进入行业关键词搜索所需的行业文章。该模块的功能是无需编写采集规则和一键操作。温馨提示:使用文章时,请注明文章的出处并尊重原创文本的版权。

3、百度新闻采集:一键搜索各行各业的新闻文章,数据源来自百度新闻搜索引擎,资源丰富,操作灵活,无需编写任何文件[ 采集规则,但缺点是采集的文章不一定完整,但可以满足大多数用户的需求。温馨提示:使用文章时,请注明文章的出处并尊重原创文本的版权。

4、行业文章 采集:一键式搜索相关产业网站 文章,网站产业包括装饰和家居业,机械业,建材业,家电业,五金业,美容业,育儿业,金融业,游戏业,SEO业,妇女保健业等网站,资源丰富,此模块可能无法满足所有客户的需求,但是客户可以提出自己的需求,我们将改进和更新模块资源。该模块的功能是无需编写采集规则和一键操作。温馨提示:使用文章时,请注明文章的出处并尊重原创文本的版权。

5、编写规则采集:自己编写采集规则采集,采集规则符合常见的正则表达式,编写采集规则需要html代码和正则表达式规则,如果您已经编写了其他公司采集软件的采集规则,您肯定会编写我们软件的采集规则,并且我们提供了编写采集规则的文档。我们不为客户编写采集规则。如果您需要代写它们,则每条采集规则将获得10元。温馨提示:使用文章时,请注明文章的出处并尊重原创文本的版权。

6、外部链接文章资料:该模块使用大量行业语料库,通过算法将语料库随机组合以产生相关行业文章。此模块文章仅适用于质量要求不高的文章。对于通过外部链接升级的用户,此模块的特点是资源丰富且原创的程度很高,但是缺点是文章的可读性很差,用户可以在使用时选择使用它。

7、标题的批量生产:有两个功能,一个是通过关键词和规则的组合来批量生产标题,第二个功能是通过采集网络大数据获取标题。自动生成的促销具有较高的准确性,采集的标题可读,并且各有其优缺点。

8、 文章界面发布:通过简单的配置,只需单击一下,即可将生成的文章发布到您自己的网站中。目前支持的网站是Discuz门户,Dede cms,Empire E cms(新闻),PHM cms,Qibo cms,PHP168,diypage,phpwind门户。

9、 SEO批量查询工具:权重批量查询,排名批量查询,收录批量查询,长尾单词挖掘,编码批量转换,文本加密和解密。 查看全部

一款很不错的文章处理工具,可以进行素材采集

AI 文章智能处理软件是一种智能的文章 伪原创工具,可以帮助用户重组文章以形成新的文章,并且还可以执行物料采集。一个非常好的文章处理工具。

功能介绍:

1、 Intelligent 伪原创:在人工智能中使用自然语言处理技术来实现文章 伪原创处理。核心功能包括“智能伪原创”,“同义词替换伪原创”,“反义词替换伪原创”,“使用html代码在文章中随机插入关键词”,“句子改组和重组”等等等,处理后的文章 原创度和收录比率均高于80%。想了解更多功能,请下载软件进行试用。

2、门户文章 采集:一键式搜索集合相关门户网站新闻文章,网站搜狐,腾讯,新浪,网易,头条。 com,,联合早报,光明网,网站管理员网,新文化网等,用户可以进入行业关键词搜索所需的行业文章。该模块的功能是无需编写采集规则和一键操作。温馨提示:使用文章时,请注明文章的出处并尊重原创文本的版权。

3、百度新闻采集:一键搜索各行各业的新闻文章,数据源来自百度新闻搜索引擎,资源丰富,操作灵活,无需编写任何文件[ 采集规则,但缺点是采集的文章不一定完整,但可以满足大多数用户的需求。温馨提示:使用文章时,请注明文章的出处并尊重原创文本的版权。

4、行业文章 采集:一键式搜索相关产业网站 文章,网站产业包括装饰和家居业,机械业,建材业,家电业,五金业,美容业,育儿业,金融业,游戏业,SEO业,妇女保健业等网站,资源丰富,此模块可能无法满足所有客户的需求,但是客户可以提出自己的需求,我们将改进和更新模块资源。该模块的功能是无需编写采集规则和一键操作。温馨提示:使用文章时,请注明文章的出处并尊重原创文本的版权。

5、编写规则采集:自己编写采集规则采集,采集规则符合常见的正则表达式,编写采集规则需要html代码和正则表达式规则,如果您已经编写了其他公司采集软件的采集规则,您肯定会编写我们软件的采集规则,并且我们提供了编写采集规则的文档。我们不为客户编写采集规则。如果您需要代写它们,则每条采集规则将获得10元。温馨提示:使用文章时,请注明文章的出处并尊重原创文本的版权。

6、外部链接文章资料:该模块使用大量行业语料库,通过算法将语料库随机组合以产生相关行业文章。此模块文章仅适用于质量要求不高的文章。对于通过外部链接升级的用户,此模块的特点是资源丰富且原创的程度很高,但是缺点是文章的可读性很差,用户可以在使用时选择使用它。

7、标题的批量生产:有两个功能,一个是通过关键词和规则的组合来批量生产标题,第二个功能是通过采集网络大数据获取标题。自动生成的促销具有较高的准确性,采集的标题可读,并且各有其优缺点。

8、 文章界面发布:通过简单的配置,只需单击一下,即可将生成的文章发布到您自己的网站中。目前支持的网站是Discuz门户,Dede cms,Empire E cms(新闻),PHM cms,Qibo cms,PHP168,diypage,phpwind门户。

9、 SEO批量查询工具:权重批量查询,排名批量查询,收录批量查询,长尾单词挖掘,编码批量转换,文本加密和解密。

软件介绍软件支持采集好的文章伪原创处理百度收录

采集交流 • 优采云 发表了文章 • 0 个评论 • 279 次浏览 • 2021-01-22 11:33

AI Smart文章采集工具是专门为网站网站管理员创建的文章采集工具。有了它,您可以采集任何网站 文章,采集该方法非常简单,可以帮助网站站长节省大量时间。

软件简介

该软件支持采集,良好的文章伪原创处理。百度收录非常强大,支持保存本地txt,并支持保存优采云数据库文件以进行一键式发布。如果您有自媒体和软文个使用此软件的朋友,他们可以从他人编写的更好的内容中学习!您还可以将标题内容从采集修改为文章,并将其发布为软文,以提高营销效率。

软件功能

1、Intelligent 伪原创:在人工智能中使用自然语言处理技术来实现文章伪原创处理。核心功能包括“智能伪原创”,“同义词替换伪原创”,“反义词替换伪原创”,“使用html代码在文章中随机插入关键词”,“句子改组和重组”等等等,加工后的文章原创度和收录率均高于80%。想了解更多功能,请下载软件进行试用。

2、门户文章采集:一键式搜索集合相关门户网站新闻文章,网站搜狐,腾讯,新浪,网易,头条。 com,,联合早报,光明网,网站管理员网,新文化网等,用户可以进入行业关键词搜索所需的行业文章。该模块的功能是无需编写采集规则和一键操作。温馨提示:使用文章时,请注明文章的出处并尊重原创文本的版权。

3、百度新闻采集:一键搜索各行各业的新闻文章,数据源来自百度新闻搜索引擎,资源丰富,操作灵活,无需编写任何内容[ 采集规则,但缺点是采集的文章不一定完整,但可以满足大多数用户的需求。温馨提示:使用文章时,请注明文章的出处并尊重原创文本的版权。

软件亮点

1、一键采集

新闻搜索采集,百度文章采集,整个网站的一键采集,白家好文章采集,门户网站新闻采集,微信文章采集,列表文章采集,风云列表采集,排名列表文章采集,问答材料采集,列表介绍采集,书写规则采集名称文章等。

2、 文章组合

材料智能组合,段落的随机组合,句子的随机组合,核心内容组合,材料排列和组合,批次文章组合,文本批次划分,段落成对组合,整个文本组合。

3、图片下载

通过关键词自动搜索图片,自动下载,自动删除成批图片中的水印,并在上传图片时自动获取远程网址

更新日志

修复已知错误 查看全部

软件介绍软件支持采集好的文章伪原创处理百度收录

AI Smart文章采集工具是专门为网站网站管理员创建的文章采集工具。有了它,您可以采集任何网站 文章,采集该方法非常简单,可以帮助网站站长节省大量时间。

软件简介

该软件支持采集,良好的文章伪原创处理。百度收录非常强大,支持保存本地txt,并支持保存优采云数据库文件以进行一键式发布。如果您有自媒体和软文个使用此软件的朋友,他们可以从他人编写的更好的内容中学习!您还可以将标题内容从采集修改为文章,并将其发布为软文,以提高营销效率。

软件功能

1、Intelligent 伪原创:在人工智能中使用自然语言处理技术来实现文章伪原创处理。核心功能包括“智能伪原创”,“同义词替换伪原创”,“反义词替换伪原创”,“使用html代码在文章中随机插入关键词”,“句子改组和重组”等等等,加工后的文章原创度和收录率均高于80%。想了解更多功能,请下载软件进行试用。

2、门户文章采集:一键式搜索集合相关门户网站新闻文章,网站搜狐,腾讯,新浪,网易,头条。 com,,联合早报,光明网,网站管理员网,新文化网等,用户可以进入行业关键词搜索所需的行业文章。该模块的功能是无需编写采集规则和一键操作。温馨提示:使用文章时,请注明文章的出处并尊重原创文本的版权。

3、百度新闻采集:一键搜索各行各业的新闻文章,数据源来自百度新闻搜索引擎,资源丰富,操作灵活,无需编写任何内容[ 采集规则,但缺点是采集的文章不一定完整,但可以满足大多数用户的需求。温馨提示:使用文章时,请注明文章的出处并尊重原创文本的版权。

软件亮点

1、一键采集

新闻搜索采集,百度文章采集,整个网站的一键采集,白家好文章采集,门户网站新闻采集,微信文章采集,列表文章采集,风云列表采集,排名列表文章采集,问答材料采集,列表介绍采集,书写规则采集名称文章等。

2、 文章组合

材料智能组合,段落的随机组合,句子的随机组合,核心内容组合,材料排列和组合,批次文章组合,文本批次划分,段落成对组合,整个文本组合。

3、图片下载

通过关键词自动搜索图片,自动下载,自动删除成批图片中的水印,并在上传图片时自动获取远程网址

更新日志

修复已知错误

优采云万能文章采集器是一款基于高精度正文识别算法

采集交流 • 优采云 发表了文章 • 0 个评论 • 267 次浏览 • 2021-01-18 08:02

优采云Universal文章采集器是基于高精度文本识别算法的Internet文章采集器。支持按关键词采集百度等搜索引擎新闻来源()和pan-pages(),支持采集指定的网站列在所有文章下。

软件简介

优采云该软件是第一个创建智能通用算法的软件,该算法可以准确地提取网页的正文部分并将其另存为文章。

支持标签,链接,电子邮件等的格式化处理。还有关键词插入功能,可以识别标签或标点符号的插入,并可以识别英语空格的插入。

文章的翻译功能更多,也就是说,文章可以从一种语言(例如中文)转换为另一种语言(例如英语或日语),然后再从英语或日语转换回中文。这是一个翻译周期。您可以将翻译周期设置为循环多次(翻译次数)。

采集文章+ translation伪原创可以满足各个领域的大多数网站管理员朋友的文章需求。

一些公关处理和信息研究公司所要求的由专业公司开发的信息采集系统通常售价成千上万甚至更高,并且优采云的软件也是一条信息采集该系统和功能与市场上昂贵的软件有相似之处,但价格仅为几百元,您将知道如何尝试性价比。

功能说明

什么是高精度文本识别算法

优采云独立研究和开发了该算法,该算法可以从网页中提取身体部位,通常精度为95%。如果进一步设置最小字数,则采集的文章的准确性(正确性)可以达到99%。同时,文章标题也实现了99%的提取精度。当然,当某些网页布局格式混乱且不规则时,准确性可能会降低。

文本提取模式

文本提取算法具有3种模式:标准,严格和精确标记。在大多数情况下,标准模式和严格模式是相同的提取结果。以下是一些特殊情况:

标准模式:这是常规提取。在大多数情况下,可以准确地提取文本,但是某些特殊页面会导致提取一些不必要的内容(但是这种模式可以更好地识别文章页面,类似于百度的体验)

<p>严格模式:顾名思义,它比标准模式要严格一些,它可以很大程度上避免提取无关内容作为主要文本,但是对于特殊的细分页面,例如百度体验页面(不通用 查看全部

优采云万能文章采集器是一款基于高精度正文识别算法

优采云Universal文章采集器是基于高精度文本识别算法的Internet文章采集器。支持按关键词采集百度等搜索引擎新闻来源()和pan-pages(),支持采集指定的网站列在所有文章下。

软件简介

优采云该软件是第一个创建智能通用算法的软件,该算法可以准确地提取网页的正文部分并将其另存为文章。

支持标签,链接,电子邮件等的格式化处理。还有关键词插入功能,可以识别标签或标点符号的插入,并可以识别英语空格的插入。

文章的翻译功能更多,也就是说,文章可以从一种语言(例如中文)转换为另一种语言(例如英语或日语),然后再从英语或日语转换回中文。这是一个翻译周期。您可以将翻译周期设置为循环多次(翻译次数)。

采集文章+ translation伪原创可以满足各个领域的大多数网站管理员朋友的文章需求。

一些公关处理和信息研究公司所要求的由专业公司开发的信息采集系统通常售价成千上万甚至更高,并且优采云的软件也是一条信息采集该系统和功能与市场上昂贵的软件有相似之处,但价格仅为几百元,您将知道如何尝试性价比。

功能说明

什么是高精度文本识别算法

优采云独立研究和开发了该算法,该算法可以从网页中提取身体部位,通常精度为95%。如果进一步设置最小字数,则采集的文章的准确性(正确性)可以达到99%。同时,文章标题也实现了99%的提取精度。当然,当某些网页布局格式混乱且不规则时,准确性可能会降低。

文本提取模式

文本提取算法具有3种模式:标准,严格和精确标记。在大多数情况下,标准模式和严格模式是相同的提取结果。以下是一些特殊情况:

标准模式:这是常规提取。在大多数情况下,可以准确地提取文本,但是某些特殊页面会导致提取一些不必要的内容(但是这种模式可以更好地识别文章页面,类似于百度的体验)

<p>严格模式:顾名思义,它比标准模式要严格一些,它可以很大程度上避免提取无关内容作为主要文本,但是对于特殊的细分页面,例如百度体验页面(不通用

最新版:AI智能文章采集软件 V1.4 官方版

采集交流 • 优采云 发表了文章 • 0 个评论 • 283 次浏览 • 2021-01-11 13:05

新闻搜索采集,百度文章采集,一站式整体网站采集,白家号文章采集,门户网站新闻采集,微信文章采集,列表文章采集,风云列表采集,排名列表文章采集,问答数据采集,列表摘要文件采集,编写规则以采集指定的文章等。

2.产品组合

材料的智能组合,段落的随机组合,句子的随机组合,核心内容组合,材料安排组合,批处理文章组合,文本批处理分段,段落对组合和整个文本组合。

3.图片下载

通过关键字自动搜索图片,自动下载,自动删除水印以批量修改图片并自动获取用于上传图片的远程URL

软件功能:1.Smart伪原创:人工智能中的自然语言处理技术用于处理伪原创文章。核心功能包括“智能伪原创”,“同义词替换伪原创”,“反义词替换伪原创”,“使用html代码在文章中随机插入关键字”,“句子加扰和重组”等等。加工产品的原创性能和夹杂率均在80%以上。想了解更多功能,请下载软件进行试用。

2.门户网站 文章采集:一键搜索相关门户网站新闻文章,例如搜狐,腾讯,新浪,网易,头条,新栏目,联合早报,光明。 ,以及New等,用户可以输入行业关键字来搜索所需的行业文章。该模块的功能是无需编写采集规则和一键操作。提醒:使用本文时,请注明文章的出处并尊重原创文本的版权。

3.百度新闻精选:一键搜索各行各业的新闻报道。数据源来自百度新闻搜索引擎。它资源丰富,操作灵活,不需要编写任何采集规则。但是,缺点是采集的文章不一定完整,但可以满足大多数用户的需求。提醒:使用本文时,请注明文章的出处并尊重原创文本的版权 查看全部

最新版:AI智能文章采集软件 V1.4 官方版

新闻搜索采集,百度文章采集,一站式整体网站采集,白家号文章采集,门户网站新闻采集,微信文章采集,列表文章采集,风云列表采集,排名列表文章采集,问答数据采集,列表摘要文件采集,编写规则以采集指定的文章等。

2.产品组合

材料的智能组合,段落的随机组合,句子的随机组合,核心内容组合,材料安排组合,批处理文章组合,文本批处理分段,段落对组合和整个文本组合。

3.图片下载

通过关键字自动搜索图片,自动下载,自动删除水印以批量修改图片并自动获取用于上传图片的远程URL

软件功能:1.Smart伪原创:人工智能中的自然语言处理技术用于处理伪原创文章。核心功能包括“智能伪原创”,“同义词替换伪原创”,“反义词替换伪原创”,“使用html代码在文章中随机插入关键字”,“句子加扰和重组”等等。加工产品的原创性能和夹杂率均在80%以上。想了解更多功能,请下载软件进行试用。

2.门户网站 文章采集:一键搜索相关门户网站新闻文章,例如搜狐,腾讯,新浪,网易,头条,新栏目,联合早报,光明。 ,以及New等,用户可以输入行业关键字来搜索所需的行业文章。该模块的功能是无需编写采集规则和一键操作。提醒:使用本文时,请注明文章的出处并尊重原创文本的版权。

3.百度新闻精选:一键搜索各行各业的新闻报道。数据源来自百度新闻搜索引擎。它资源丰富,操作灵活,不需要编写任何采集规则。但是,缺点是采集的文章不一定完整,但可以满足大多数用户的需求。提醒:使用本文时,请注明文章的出处并尊重原创文本的版权

解密:繁殖蜘蛛池 - 智能抓取无限模板,云端采集文章资源

采集交流 • 优采云 发表了文章 • 0 个评论 • 252 次浏览 • 2020-12-23 08:06

开发繁殖蜘蛛库程序花了3个月的时间,该程序结合了克隆,采集,发布,挖掘,短URL生成,外推数据库生成,关键词分析,句子数据库生成和段落数据库生成。 ,文章库生成,其他最先进的和传统的站群模式,多线程处理,站群程序的技术突破最终将归因于网站结构级别的深度以及内容资源的新鲜和稀有,因此,该程序的设计和开发重点是克隆网站和准确的采集 文章数据。最后,可以无缝编码站群生成的链接并将其发布到高重量门户网站的网站论坛中,以使您的蜘蛛池不仅每天都有每天访问的蜘蛛,而且还可以引入高重量的蜘蛛每天定向!

功能:

1、无限繁殖蜘蛛池模板

克隆模板是此开发的主要重点。 站群最终的技术突破将归因于网站的层次结构和结构多样化。该程序采用金字塔模式来模拟蜘蛛爬网Internet上的前端页面。 网站理论如上所述,只要可以将运行软件的计算机的IP连接到捕获的网站,您就可以在五秒钟内克隆任何Internet 网站模板!

a。您可以设置精确的模板克隆种子,手动输入要克隆的行业关键词,或从文本导入!

b。您可以选择克隆镜像的深度。选择模式为:仅克隆种子和无限循环挂机克隆

c。超级强大的模板SEO处理功能,可以根据需要设置抓取的模板

[c-1]。克隆的模板的标题可以完全替换为关键词,也可以在保留网站标题的同时在标题的任意位置插入关键词。

[c-2],可以正确处理克隆的模板锚链接:

[c-2-1]:当前的独立域名二级域名链轮模式

[c-2-2]:站群混合域二级域链轮模式

[c-2-3]:当前的独立域名目录链轮模式

[c-2-4]:站群混合域名目录链轮模式

[c-2-5]:Primal Force超级外推库模式,将Primal Force的外推链接首先快速插入克隆模板中收录

[c-2-6]:您可以将二级域名设置为数字

[c-2-7]:您可以将二级域名设置为字母

[c-2-8]:您可以将二级域名设置为字符

[c-2-9]:您可以设置目录的深度级别,例如:/ 12345/12345/12345/12345 /只需将目录级别设置为5,它将自动生成

[c-3],可以随意替换克隆模板文章的内容

[c-3-1]:您可以保持克隆的网站内容结构不变

[c-3-2]:可以随机调用站群句子数据库以生成原创文章植入物克隆模板。 (可读性差,请谨慎使用)

[c-3-2]:站群段库可以被随机调用以生成原创文章植入克隆模板。 (高可读性,高度原创)

[c-3-1]:您可以随机调用整个文章库并将其插入克隆模板。 (高度可读)

[c-4]克隆的模板图片和视频的多种处理模式,可以使原创图片保持不变,也可以调用站群图片和视频数据库资源。

[c-5],您可以设置克隆的网站线程数以最快的速度爬网并返回模板资源。

[c-6],可以设置克隆种子的挖掘深度。克隆种子是通过百度搜索植入的,用于设置克隆的百度搜索结果页面的页面深度

[c-7],可以设置用于克隆网站任务的模板数量。当克隆的模板数量达到任务数量时,克隆将停止,并且克隆数量将不会达到,并且计算机将按周期挂机。

[c-8],您可以设置克隆网站的间隔时间,这样站群服务器的所有内存都不会在克隆时被占用。不会影响站群的访问速度。

[c-9],您可以设置克隆数据库网站的总容量来存储数据库。达到克隆数据库容量后,可以选择停止克隆或清空以前克隆的模板循环克隆。此设置的最大好处是什么?可以避免过多的存储容量的影响站群读取速度

度。可以节省大量CPU资源。

[c-10],可以设置克隆网站过滤器,该方法非常简单,如果您不需要克隆某个网站模板。只需在克隆过滤器中输入URL,就会自动跳过克隆过滤器中的URL。克隆下一个。

【c-11】克隆功能采用独立的过程,可以随时暂停或继续。在挂机克隆过程中,它不会影响程序其他功能的使用。

2、数据采集器,其中精度采集和广义采集并存。 “此功能是为此站群程序量身定制的”

a。该程序内置了五十个国内行业门户网站网站 采集。行业范围:门户新闻,彩票信息,游戏体验,足球比赛,欧洲杯等。您只需单击一下即可将网站的这些文章 采集转移到本地计算机上

[a-1]:您可以选择采集所需的内容资源,从而使其与站群内容更加相关,这有利于SEO。

[a-2]:您可以将文章仓储方法设置到句子数据库(句子数据库称为句子数据库),并且句子数据库将自动为克隆过程提供数据。在克隆模板上执行文章优化。

[a-3]:您可以将文章存储方法设置为段落库,(带有调用单元的段落称为段落库),该段落库将自动为克隆过程提供数据。在克隆模板上执行文章优化。

[a-4]:您可以为整个库设置文章仓储方法(整个库称为整个库),整个库将自动向克隆过程提供数据,并执行克隆模板文章优化。

[a-5]:您可以设置文章 采集模式

[a-5-1]:每天更新一次全局文章,365天的智能挂机自动更新,一旦获得大约5000个文章,就会获得50个准确的采集种子采集,小型站群足以使用。

[a-5-2]:文章实时监视更新,只要网站具有内容更新,则立即启动采集进程进行捕获。此模式更适合大型站群或蜘蛛池。返回的文章绝对是Internet上最及时的,而不是那些垃圾站群破烂的文章。

[a-5-3]:文章智能数据库管理,您可以设置在文章的容量达到或清空采集之后循环时停止的文章数,主要是为了防止从中读取冗余数据消耗CPU。

[a-5-4]:您可以设置单个文章文章的总KB。超过文本大小时,文本将自动切成多篇文章文章。

[a-5-5]:文章 采集使用独立的系统进程,可以暂停或继续该进程,而不会影响软件的其他功能和站群的运行。

b。广泛使用搜索引擎作为切入点采集

[b-1]。首先选择您的站群行业,然后设置采集数据的种子资源。

[b-2],配置文章存储和采集选项

[b-3],从百度门户自动返回pan 采集数据

[b-4],平移采集 文章不准确采集 文章高品质

[b-5],当前最受欢迎的关键词欧洲杯锦标赛已锁定

3、集成了云编码,渗透了验证代码,挂断并将站群生成的链接推向主流的高重量行业网站。

a。云推送可以选择数据库发布模式和站群模式。如果同时选择了两种推送模式,则将首先使用数据库模式。数据库链接和文章发布完成后,无缝切换到站群模式。

[a-1]数据库模式,此推释放模式适用于软文释放,而针对网站则可以增加重量。

[a-1-1]:在软件界面数据库中,本地导入链接,关键词,文章标题和文章内容。

[a-1-2]:自动从文章中选择一个随机句子作为文章的标题并发布

[a-1-3]:随机帖子,其链接对应于关键词

[a-2] 站群模式,智能地调用站群生成要发布的链接库,并每天向蜘蛛池中引入高重量的蜘蛛。

[a-2-1]:您可以从句子数据库中随机调用一个句子作为文章的标题

[a-2-2]:您可以选择在标题关键词中随机插入优化

[a-2-3]:您可以在标题的随机位置插入一个句子,适合外推,消除负面因素,公共关系团队,产品在线销售等。

[a-2-4]:可以设置多少个句子语料库单元来组合一篇文章文章

[a-2-5]:可以设置多少个段落库单位来合并一篇文章文章

[a-2-6]:您可以设置为调用整个文章库。一些高强度门户网站论坛对文章进行了严格的质量筛选,而整个文章更适合发布。

[a-2-7]:您可以在文章的末尾随机插入一个句子,该句子将出现在收录之后的百度快照中。如QQ。电话。适用于推断,消除负面影响,公共关系团队,产品在线销售等。

[a-2-8]:您可以在文章中插入指定数量的ubb超链接。将权重导入您的站群或蜘蛛池

[a-2-9]:您可以在文章中插入指定数量的域名文本链,以增加域名的显示范围,并允许蜘蛛爬行更多的道路。

[a-2-10]:您可以将插入的网站链接设置为:域名数据库,短URL链接数据库,外推链接,前任的权力等。

[a-2-11]:您可以设置关键词在文章中出现的次数

[a-2-12]:您可以设置过滤重复的关键词

4、高速外推链接生成功能

[a-1]:您可以在外推法关键词的随机位置插入一个句子,该句子将出现在收录之后的百度快照中。如QQ。电话。适用于推断,消除负面影响,公共关系团队,产品在线销售等。

[a-2]:支持本地导入文本关键词,并且关键词可以删除或编辑。

[a-3]:您可以设置路径以保存生成的外推链接,将其自动保存到站群以调用或导出到外部,

【a-4】:可以设置外推链接的文本存储容量为多少kb,达到该容量后将自动剪切。

[a-5]:外推链接的生成模式完全支持UTF-8和GBK-2312

5、超级强大的短URL生成界面[防止删除]

[a-1]:该软件的简短URL生成界面是该平台的最新版本。最新更新

[a-2]:采用后高速数据包获取模式。

[a-3]:程序界面完美支持短URL平台,例如tinyurl / dwz / 985 / t / isgd / baidu,并将在以后继续更新

查看全部

解密:繁殖蜘蛛池 - 智能抓取无限模板,云端采集文章资源

开发繁殖蜘蛛库程序花了3个月的时间,该程序结合了克隆,采集,发布,挖掘,短URL生成,外推数据库生成,关键词分析,句子数据库生成和段落数据库生成。 ,文章库生成,其他最先进的和传统的站群模式,多线程处理,站群程序的技术突破最终将归因于网站结构级别的深度以及内容资源的新鲜和稀有,因此,该程序的设计和开发重点是克隆网站和准确的采集 文章数据。最后,可以无缝编码站群生成的链接并将其发布到高重量门户网站的网站论坛中,以使您的蜘蛛池不仅每天都有每天访问的蜘蛛,而且还可以引入高重量的蜘蛛每天定向!

功能:

1、无限繁殖蜘蛛池模板

克隆模板是此开发的主要重点。 站群最终的技术突破将归因于网站的层次结构和结构多样化。该程序采用金字塔模式来模拟蜘蛛爬网Internet上的前端页面。 网站理论如上所述,只要可以将运行软件的计算机的IP连接到捕获的网站,您就可以在五秒钟内克隆任何Internet 网站模板!

a。您可以设置精确的模板克隆种子,手动输入要克隆的行业关键词,或从文本导入!

b。您可以选择克隆镜像的深度。选择模式为:仅克隆种子和无限循环挂机克隆

c。超级强大的模板SEO处理功能,可以根据需要设置抓取的模板

[c-1]。克隆的模板的标题可以完全替换为关键词,也可以在保留网站标题的同时在标题的任意位置插入关键词。

[c-2],可以正确处理克隆的模板锚链接:

[c-2-1]:当前的独立域名二级域名链轮模式

[c-2-2]:站群混合域二级域链轮模式

[c-2-3]:当前的独立域名目录链轮模式

[c-2-4]:站群混合域名目录链轮模式

[c-2-5]:Primal Force超级外推库模式,将Primal Force的外推链接首先快速插入克隆模板中收录

[c-2-6]:您可以将二级域名设置为数字

[c-2-7]:您可以将二级域名设置为字母

[c-2-8]:您可以将二级域名设置为字符

[c-2-9]:您可以设置目录的深度级别,例如:/ 12345/12345/12345/12345 /只需将目录级别设置为5,它将自动生成

[c-3],可以随意替换克隆模板文章的内容

[c-3-1]:您可以保持克隆的网站内容结构不变

[c-3-2]:可以随机调用站群句子数据库以生成原创文章植入物克隆模板。 (可读性差,请谨慎使用)

[c-3-2]:站群段库可以被随机调用以生成原创文章植入克隆模板。 (高可读性,高度原创)

[c-3-1]:您可以随机调用整个文章库并将其插入克隆模板。 (高度可读)

[c-4]克隆的模板图片和视频的多种处理模式,可以使原创图片保持不变,也可以调用站群图片和视频数据库资源。

[c-5],您可以设置克隆的网站线程数以最快的速度爬网并返回模板资源。

[c-6],可以设置克隆种子的挖掘深度。克隆种子是通过百度搜索植入的,用于设置克隆的百度搜索结果页面的页面深度

[c-7],可以设置用于克隆网站任务的模板数量。当克隆的模板数量达到任务数量时,克隆将停止,并且克隆数量将不会达到,并且计算机将按周期挂机。

[c-8],您可以设置克隆网站的间隔时间,这样站群服务器的所有内存都不会在克隆时被占用。不会影响站群的访问速度。

[c-9],您可以设置克隆数据库网站的总容量来存储数据库。达到克隆数据库容量后,可以选择停止克隆或清空以前克隆的模板循环克隆。此设置的最大好处是什么?可以避免过多的存储容量的影响站群读取速度

度。可以节省大量CPU资源。

[c-10],可以设置克隆网站过滤器,该方法非常简单,如果您不需要克隆某个网站模板。只需在克隆过滤器中输入URL,就会自动跳过克隆过滤器中的URL。克隆下一个。

【c-11】克隆功能采用独立的过程,可以随时暂停或继续。在挂机克隆过程中,它不会影响程序其他功能的使用。

2、数据采集器,其中精度采集和广义采集并存。 “此功能是为此站群程序量身定制的”

a。该程序内置了五十个国内行业门户网站网站 采集。行业范围:门户新闻,彩票信息,游戏体验,足球比赛,欧洲杯等。您只需单击一下即可将网站的这些文章 采集转移到本地计算机上

[a-1]:您可以选择采集所需的内容资源,从而使其与站群内容更加相关,这有利于SEO。

[a-2]:您可以将文章仓储方法设置到句子数据库(句子数据库称为句子数据库),并且句子数据库将自动为克隆过程提供数据。在克隆模板上执行文章优化。

[a-3]:您可以将文章存储方法设置为段落库,(带有调用单元的段落称为段落库),该段落库将自动为克隆过程提供数据。在克隆模板上执行文章优化。

[a-4]:您可以为整个库设置文章仓储方法(整个库称为整个库),整个库将自动向克隆过程提供数据,并执行克隆模板文章优化。

[a-5]:您可以设置文章 采集模式

[a-5-1]:每天更新一次全局文章,365天的智能挂机自动更新,一旦获得大约5000个文章,就会获得50个准确的采集种子采集,小型站群足以使用。

[a-5-2]:文章实时监视更新,只要网站具有内容更新,则立即启动采集进程进行捕获。此模式更适合大型站群或蜘蛛池。返回的文章绝对是Internet上最及时的,而不是那些垃圾站群破烂的文章。

[a-5-3]:文章智能数据库管理,您可以设置在文章的容量达到或清空采集之后循环时停止的文章数,主要是为了防止从中读取冗余数据消耗CPU。

[a-5-4]:您可以设置单个文章文章的总KB。超过文本大小时,文本将自动切成多篇文章文章。

[a-5-5]:文章 采集使用独立的系统进程,可以暂停或继续该进程,而不会影响软件的其他功能和站群的运行。

b。广泛使用搜索引擎作为切入点采集

[b-1]。首先选择您的站群行业,然后设置采集数据的种子资源。

[b-2],配置文章存储和采集选项

[b-3],从百度门户自动返回pan 采集数据

[b-4],平移采集 文章不准确采集 文章高品质

[b-5],当前最受欢迎的关键词欧洲杯锦标赛已锁定

3、集成了云编码,渗透了验证代码,挂断并将站群生成的链接推向主流的高重量行业网站。

a。云推送可以选择数据库发布模式和站群模式。如果同时选择了两种推送模式,则将首先使用数据库模式。数据库链接和文章发布完成后,无缝切换到站群模式。

[a-1]数据库模式,此推释放模式适用于软文释放,而针对网站则可以增加重量。

[a-1-1]:在软件界面数据库中,本地导入链接,关键词,文章标题和文章内容。

[a-1-2]:自动从文章中选择一个随机句子作为文章的标题并发布

[a-1-3]:随机帖子,其链接对应于关键词

[a-2] 站群模式,智能地调用站群生成要发布的链接库,并每天向蜘蛛池中引入高重量的蜘蛛。

[a-2-1]:您可以从句子数据库中随机调用一个句子作为文章的标题

[a-2-2]:您可以选择在标题关键词中随机插入优化

[a-2-3]:您可以在标题的随机位置插入一个句子,适合外推,消除负面因素,公共关系团队,产品在线销售等。

[a-2-4]:可以设置多少个句子语料库单元来组合一篇文章文章

[a-2-5]:可以设置多少个段落库单位来合并一篇文章文章

[a-2-6]:您可以设置为调用整个文章库。一些高强度门户网站论坛对文章进行了严格的质量筛选,而整个文章更适合发布。

[a-2-7]:您可以在文章的末尾随机插入一个句子,该句子将出现在收录之后的百度快照中。如QQ。电话。适用于推断,消除负面影响,公共关系团队,产品在线销售等。

[a-2-8]:您可以在文章中插入指定数量的ubb超链接。将权重导入您的站群或蜘蛛池

[a-2-9]:您可以在文章中插入指定数量的域名文本链,以增加域名的显示范围,并允许蜘蛛爬行更多的道路。

[a-2-10]:您可以将插入的网站链接设置为:域名数据库,短URL链接数据库,外推链接,前任的权力等。

[a-2-11]:您可以设置关键词在文章中出现的次数

[a-2-12]:您可以设置过滤重复的关键词

4、高速外推链接生成功能

[a-1]:您可以在外推法关键词的随机位置插入一个句子,该句子将出现在收录之后的百度快照中。如QQ。电话。适用于推断,消除负面影响,公共关系团队,产品在线销售等。

[a-2]:支持本地导入文本关键词,并且关键词可以删除或编辑。

[a-3]:您可以设置路径以保存生成的外推链接,将其自动保存到站群以调用或导出到外部,

【a-4】:可以设置外推链接的文本存储容量为多少kb,达到该容量后将自动剪切。

[a-5]:外推链接的生成模式完全支持UTF-8和GBK-2312

5、超级强大的短URL生成界面[防止删除]

[a-1]:该软件的简短URL生成界面是该平台的最新版本。最新更新

[a-2]:采用后高速数据包获取模式。

[a-3]:程序界面完美支持短URL平台,例如tinyurl / dwz / 985 / t / isgd / baidu,并将在以后继续更新

事实:通过段落组合文章的秘密你知道多少

采集交流 • 优采云 发表了文章 • 0 个评论 • 176 次浏览 • 2020-12-04 11:32

网站管理员对文章的需求很大,我们必须考虑使用文章段落材料进行组合以获得更多的文章,以满足网站材料更新的需求。不仅段落组合文章可以获取搜索引擎收录,还需要一系列操作才能获得好的组合文章。

1、首先使用大量相关的长尾词采集来发布高度相关的文章,只有高相关度组合文章才具有高质量。

2、提取原创标题并先保存它们,然后组合文章以适合您的需要。如果您的采集的文章很好,则这些标题的质量很好,可以使用两次。如果您不想使用原创标题,也可以使用标题组合或所需的标题。

3、过滤垃圾邮件,例如:过滤收录广告的段落,过滤收录其他人的品牌的段落,过滤收录联系信息的段落,过滤单词太少的段落。如果段落材料足够,则可以过滤出收录指定的关键词的段落。

4、文章 伪原创处理,首先文章使用智能伪原创方法处理整篇文章,因此以后合并的文章不需要伪原创处理。

5、过滤单词过少的段落(建议过滤少于150个单词的段落和大于400个单词的段落),同时保留收录指定的关键词的段落。

6、开始随机组合文章,建议将文章的段落放在第10至20段中。合并的文章使用您自己准备的标题作为文章标题。

将7、文章组合后,插入关键词和图片文章以完成组合,然后导出html格式以与软件版本配合使用。

总结:以上所有功能均可通过Henxi Software的“ AI 文章智能处理软件”实现。通过自动处理,网站管理员可以快速获取符合搜索引擎优化要求的文章素材!

查看全部

您对段落组合文章的秘密了解多少?

网站管理员对文章的需求很大,我们必须考虑使用文章段落材料进行组合以获得更多的文章,以满足网站材料更新的需求。不仅段落组合文章可以获取搜索引擎收录,还需要一系列操作才能获得好的组合文章。

1、首先使用大量相关的长尾词采集来发布高度相关的文章,只有高相关度组合文章才具有高质量。

2、提取原创标题并先保存它们,然后组合文章以适合您的需要。如果您的采集的文章很好,则这些标题的质量很好,可以使用两次。如果您不想使用原创标题,也可以使用标题组合或所需的标题。

3、过滤垃圾邮件,例如:过滤收录广告的段落,过滤收录其他人的品牌的段落,过滤收录联系信息的段落,过滤单词太少的段落。如果段落材料足够,则可以过滤出收录指定的关键词的段落。

4、文章 伪原创处理,首先文章使用智能伪原创方法处理整篇文章,因此以后合并的文章不需要伪原创处理。

5、过滤单词过少的段落(建议过滤少于150个单词的段落和大于400个单词的段落),同时保留收录指定的关键词的段落。

6、开始随机组合文章,建议将文章的段落放在第10至20段中。合并的文章使用您自己准备的标题作为文章标题。

将7、文章组合后,插入关键词和图片文章以完成组合,然后导出html格式以与软件版本配合使用。

总结:以上所有功能均可通过Henxi Software的“ AI 文章智能处理软件”实现。通过自动处理,网站管理员可以快速获取符合搜索引擎优化要求的文章素材!

完美:通过段落组合文章的秘密你知道多少

采集交流 • 优采云 发表了文章 • 0 个评论 • 169 次浏览 • 2020-11-15 08:00

网站管理员对文章的需求很大,我们必须考虑使用文章段落材料进行组合以获得更多的文章,以满足网站材料更新的需求。不仅段落组合文章可以得到搜索引擎的收录,还需要一系列操作才能获得好的组合文章。

1、首先使用大量相关的长尾词采集来发布高度相关的文章,只有高相关度组合文章才具有高质量。

2、提取原创标题并先保存它们,然后组合文章以适合您的需要。如果您的采集的文章很好,则这些标题的质量很好,可以使用两次。如果您不想使用原创标题,也可以使用标题组合或所需的标题。

3、过滤垃圾邮件,例如:过滤收录广告的段落,过滤收录他人品牌的段落,过滤收录联系信息的段落,过滤单词太少的段落。如果段落材料足够,则可以过滤出收录指定的关键词的段落。

4、文章 伪原创处理,首先文章使用智能伪原创方法处理整篇文章,因此以后合并的文章不需要伪原创处理。

5、过滤单词过少的段落(建议过滤少于150个单词的段落和大于400个单词的段落),同时保留收录指定的关键词的段落。

6、开始随机组合文章,建议将文章的段落放在第10至20段中。组合的文章使用您自己准备的标题作为文章标题。

将7、文章组合后,插入关键词和图片文章以完成组合,然后导出html格式以与软件版本配合使用。

总结:上述所有功能都可以通过Henxi Software的“ AI 文章智能处理软件”来实现。通过自动处理,网站管理员可以快速获取符合搜索引擎优化要求的文章素材!

查看全部

您对段落组合文章的秘密了解多少?

网站管理员对文章的需求很大,我们必须考虑使用文章段落材料进行组合以获得更多的文章,以满足网站材料更新的需求。不仅段落组合文章可以得到搜索引擎的收录,还需要一系列操作才能获得好的组合文章。

1、首先使用大量相关的长尾词采集来发布高度相关的文章,只有高相关度组合文章才具有高质量。

2、提取原创标题并先保存它们,然后组合文章以适合您的需要。如果您的采集的文章很好,则这些标题的质量很好,可以使用两次。如果您不想使用原创标题,也可以使用标题组合或所需的标题。

3、过滤垃圾邮件,例如:过滤收录广告的段落,过滤收录他人品牌的段落,过滤收录联系信息的段落,过滤单词太少的段落。如果段落材料足够,则可以过滤出收录指定的关键词的段落。

4、文章 伪原创处理,首先文章使用智能伪原创方法处理整篇文章,因此以后合并的文章不需要伪原创处理。

5、过滤单词过少的段落(建议过滤少于150个单词的段落和大于400个单词的段落),同时保留收录指定的关键词的段落。

6、开始随机组合文章,建议将文章的段落放在第10至20段中。组合的文章使用您自己准备的标题作为文章标题。

将7、文章组合后,插入关键词和图片文章以完成组合,然后导出html格式以与软件版本配合使用。

总结:上述所有功能都可以通过Henxi Software的“ AI 文章智能处理软件”来实现。通过自动处理,网站管理员可以快速获取符合搜索引擎优化要求的文章素材!

分享文章:WordPress自动采集发布文章01-使用优采云采集目标网站

采集交流 • 优采云 发表了文章 • 0 个评论 • 311 次浏览 • 2020-09-28 08:02

优采云采集目标网站有什么好处

优采云采集目标网站有什么好处?

它将根据我们指定的网站执行采集,并且采集的内容与我们的网站的内容高度相关。

为什么不使用站群软件采集? 站群软件不同于优采云采集。 站群软件使用pan 采集,而优采云是定向采集。 Pan 采集的意思是:根据我们设计的关键词,搜索相关内容采集,例如,站群软件内置了成千上万的网站,然后从这些网站中提取采集内容,将根据您设置的关键词搜索这些内容。然后索引数千个网站至采集相关内容。这些网站通常是门户网站,或为百度通过搜索引擎知道的一些相关内容建立索引,这将导致站群软件的使用。采集 文章的质量不高,且重复率很高采集中的文章会很高,因为您采集的文章其他人也可能会采集,因为您不是唯一使用站群软件的人。

因此,优采云采集的优点是:我认为采集其中网站是采集,而网站更相关。 文章质量也会更高。

如何独立学习优采云采集

您可以访问此网站:优采云论坛用法教程

参加实战采集

我在这里演示优采云如何采集:

例如,我来到采集虚幻私立学校的文章:

1.打开优采云并创建一个新任务

首先,使用任务名称:“虚幻私立学校”

.png-wordpress自动发布文章01-使用优采云采集目标网站

这里有三个步骤:

在本节中,我们解释了前两个步骤:

首先,我们先添加采集的网址,

这里,虚幻私立学校列表很多,我们将分多个页面进行演示:如下图所示,完成后,单击“添加”并“完成”

您必须先登录才能查看隐藏的内容。

通过这种方式,我们定义了规则。

点击“测试URL 采集”:

您可以看到:采集所有标签都已到达:

02-WordPress自动发布文章01-使用优采云采集目标网站

点击“返回修改设置”。然后点击保存。

然后右键单击任务名称“ Unreal Private School”,然后单击“编辑任务”:

03-WordPress自动发布文章01-使用优采云采集目标网站

从第一步开始,随机找到一篇文章文章,双击它,该文章文章可能就是典型的文章采集。

05-WordPress自动发布文章01-使用优采云采集目标网站

我们将看到采集到文章的内容具有许多html标签,因此我们需要为该内容定义一个“规则”。

首先在此处删除“作者”,“时间”和“来源”。

然后过滤标题和内容:

标题:

内容:

如果没有问题,您可以在此处继续测试采集中的数据是否正确

保存设置,然后选择网站地址和内容。

06-WordPress自动发布文章01-使用优采云采集目标网站

然后开始采集。

采集完成后,我们可以检查采集中的数据是否正确:

07-WordPress自动发布文章01-使用优采云采集目标网站

如果两者都存在,则表示采集的数据符合我们的要求。 查看全部

WordPress自动采集发布文章01-使用优采云采集目标网站

优采云采集目标网站有什么好处

优采云采集目标网站有什么好处?

它将根据我们指定的网站执行采集,并且采集的内容与我们的网站的内容高度相关。

为什么不使用站群软件采集? 站群软件不同于优采云采集。 站群软件使用pan 采集,而优采云是定向采集。 Pan 采集的意思是:根据我们设计的关键词,搜索相关内容采集,例如,站群软件内置了成千上万的网站,然后从这些网站中提取采集内容,将根据您设置的关键词搜索这些内容。然后索引数千个网站至采集相关内容。这些网站通常是门户网站,或为百度通过搜索引擎知道的一些相关内容建立索引,这将导致站群软件的使用。采集 文章的质量不高,且重复率很高采集中的文章会很高,因为您采集的文章其他人也可能会采集,因为您不是唯一使用站群软件的人。

因此,优采云采集的优点是:我认为采集其中网站是采集,而网站更相关。 文章质量也会更高。

如何独立学习优采云采集

您可以访问此网站:优采云论坛用法教程

参加实战采集

我在这里演示优采云如何采集:

例如,我来到采集虚幻私立学校的文章:

1.打开优采云并创建一个新任务

首先,使用任务名称:“虚幻私立学校”

.png-wordpress自动发布文章01-使用优采云采集目标网站

这里有三个步骤:

在本节中,我们解释了前两个步骤:

首先,我们先添加采集的网址,

这里,虚幻私立学校列表很多,我们将分多个页面进行演示:如下图所示,完成后,单击“添加”并“完成”

您必须先登录才能查看隐藏的内容。

通过这种方式,我们定义了规则。

点击“测试URL 采集”:

您可以看到:采集所有标签都已到达:

02-WordPress自动发布文章01-使用优采云采集目标网站

点击“返回修改设置”。然后点击保存。

然后右键单击任务名称“ Unreal Private School”,然后单击“编辑任务”:

03-WordPress自动发布文章01-使用优采云采集目标网站

从第一步开始,随机找到一篇文章文章,双击它,该文章文章可能就是典型的文章采集。

05-WordPress自动发布文章01-使用优采云采集目标网站

我们将看到采集到文章的内容具有许多html标签,因此我们需要为该内容定义一个“规则”。

首先在此处删除“作者”,“时间”和“来源”。

然后过滤标题和内容:

标题:

内容:

如果没有问题,您可以在此处继续测试采集中的数据是否正确

保存设置,然后选择网站地址和内容。

06-WordPress自动发布文章01-使用优采云采集目标网站

然后开始采集。

采集完成后,我们可以检查采集中的数据是否正确:

07-WordPress自动发布文章01-使用优采云采集目标网站

如果两者都存在,则表示采集的数据符合我们的要求。

解决方案:Python自动点击京东商品价格条件,智能采集价格数据!

采集交流 • 优采云 发表了文章 • 0 个评论 • 555 次浏览 • 2020-09-13 08:01

价格数据!

注意:如果在执行操作之前和之后网页结构没有变化,则可以使用一条规则来完成;如果网络结构在前后变化,则必须使用两个或更多规则来完成;此外,如果涉及翻页,则必须将其分为两个“一个或多个”规则。有关连续操作的规则数量,请参阅“计划获取过程”一文。

一、建立第一级主题爬网目标信息

建立第一级主题的规则,然后将所需的信息映射到排序框。建议在完成内容映射后,还应进行定位标记映射,以提高定位精度和规则适应性。

注意:如果您设置了连续操作规则,则无需构建排序框。例如,方案2的第一级主题不需要构建排序框,而是使用排序框来获取一些数据(选择将在网页上显示的信息)。爬虫需要判断是否执行采集

,否则可能会错过网页的采集

。

二、设置连续动作,然后单击“新建”按钮创建一个新动作。每个动作的设置方法相同。基本操作如下:

2. 1输入目标主题名称

连续动作指向同一目标对象。如果有多个操作,并且您要指向不同的主题,请将它们分成多个规则,然后分别设置连续的操作。

2. 2选择动作类型

这种情况是单击操作,并且不同操作的应用范围不同。请根据实际操作情况选择动作类型。

2. 3将位于动作对象的xpath填充到定位表达式中

2. 4输入动作名称

告诉自己该步骤的用途,以便稍后进行修改。

2. 5高级设置

不必首先设置它,以后在调试连续动作时将使用它,这可以扩大适用的动作范围。如果需要捕获操作对象的信息,请使用xpath在高级设置的内容表达式中找到操作对象的信息。请根据需要进行设置。

注意:是否正确选择了动作类型以及xpath定位是否正确,将确定连续动作是否可以成功执行。 Xpath是用于定位html节点的标准语言。使用连续动作功能之前,请先自己掌握xpath。

根据人工步骤,我们还需要选择版本和购买方法1、购买方法2,因此我们将继续创建3个新操作并重复上述步骤。

三、调试规则

完成上述步骤后,单击“保存规则”,然后单击“爬网数据”按钮以开始试用捕获。采集

期间报告了一个错误:无法找到节点***。观察浏览器窗口,发现单击第一步后,未加载其他信息。当加载信息时,发现点击了购买方法2。无法返回执行四步单击的页面,从而导致连续执行连续操作。

鉴于上述情况,我们的解决方案是删除第四步。因为无论您是否单击购买方法2,它都不会影响产品的价格。因此,可以删除不必要的干扰步骤。

修改后,尝试再次捕获。将提取的xml转换为excel后,我发现价格和累积评估数据被捕获或捕获不正确。这是因为网页太大,加载速度太慢,并且单击后的数据将必须等待一段时间才能加载。

为了捕获所有数据,您需要延长等待时间并分别为每个操作设置延迟。单击操作步骤->高级设置->额外延迟,然后输入以秒为单位的正整数。请根据实际时间进行调试。

此外,如果不是顶部窗口,则在采集

时将反复单击它。这是因为京东网站上有一些防爬措施,这些措施必须是当前的窗口操作才能生效。因此,请检查该窗口在高级设置中是否可见,并且在采集过程中该窗口将位于顶部。请根据实际情况进行设置。

四、如何将捕获的信息映射到操作步骤?

如果要将捕获的信息与操作步骤一一对应,则必须提取操作对象的信息。有两种方法:

4. 1使用xpath在连续动作的高级设置的内容表达式中找到动作对象的信息节点。

在将定位表达式定位到动作对象的整个操作范围之后,它还收录

其自己的信息。因此,内容表达仅需要从所定位的动作对象开始,并继续对其信息进行定位。采集

时,此步骤的动作信息将记录在与该动作编号对应的动作值中,该动作编号记录了该动作的执行次数。

4. 2在整理框中获取动作对象的信息,这里也使用xpath进行定位。

执行动作对象时,其dom结构将更改。找到网页更改的结构特征,使用xpath精确定位节点,并在通过验证后,可以设置自定义xpath。

以上是使用连续动作来模拟手动操作的整个过程。尽管此过程比较麻烦,但是只要您小心谨慎和耐心地进行,最终就可以征服要爬网的网页。 查看全部

Python自动点击京东产品的价格状况并智能地采集

价格数据!

注意:如果在执行操作之前和之后网页结构没有变化,则可以使用一条规则来完成;如果网络结构在前后变化,则必须使用两个或更多规则来完成;此外,如果涉及翻页,则必须将其分为两个“一个或多个”规则。有关连续操作的规则数量,请参阅“计划获取过程”一文。

一、建立第一级主题爬网目标信息

建立第一级主题的规则,然后将所需的信息映射到排序框。建议在完成内容映射后,还应进行定位标记映射,以提高定位精度和规则适应性。

注意:如果您设置了连续操作规则,则无需构建排序框。例如,方案2的第一级主题不需要构建排序框,而是使用排序框来获取一些数据(选择将在网页上显示的信息)。爬虫需要判断是否执行采集

,否则可能会错过网页的采集

。

二、设置连续动作,然后单击“新建”按钮创建一个新动作。每个动作的设置方法相同。基本操作如下:

2. 1输入目标主题名称

连续动作指向同一目标对象。如果有多个操作,并且您要指向不同的主题,请将它们分成多个规则,然后分别设置连续的操作。

2. 2选择动作类型

这种情况是单击操作,并且不同操作的应用范围不同。请根据实际操作情况选择动作类型。

2. 3将位于动作对象的xpath填充到定位表达式中

2. 4输入动作名称

告诉自己该步骤的用途,以便稍后进行修改。

2. 5高级设置

不必首先设置它,以后在调试连续动作时将使用它,这可以扩大适用的动作范围。如果需要捕获操作对象的信息,请使用xpath在高级设置的内容表达式中找到操作对象的信息。请根据需要进行设置。

注意:是否正确选择了动作类型以及xpath定位是否正确,将确定连续动作是否可以成功执行。 Xpath是用于定位html节点的标准语言。使用连续动作功能之前,请先自己掌握xpath。

根据人工步骤,我们还需要选择版本和购买方法1、购买方法2,因此我们将继续创建3个新操作并重复上述步骤。

三、调试规则

完成上述步骤后,单击“保存规则”,然后单击“爬网数据”按钮以开始试用捕获。采集

期间报告了一个错误:无法找到节点***。观察浏览器窗口,发现单击第一步后,未加载其他信息。当加载信息时,发现点击了购买方法2。无法返回执行四步单击的页面,从而导致连续执行连续操作。

鉴于上述情况,我们的解决方案是删除第四步。因为无论您是否单击购买方法2,它都不会影响产品的价格。因此,可以删除不必要的干扰步骤。

修改后,尝试再次捕获。将提取的xml转换为excel后,我发现价格和累积评估数据被捕获或捕获不正确。这是因为网页太大,加载速度太慢,并且单击后的数据将必须等待一段时间才能加载。

为了捕获所有数据,您需要延长等待时间并分别为每个操作设置延迟。单击操作步骤->高级设置->额外延迟,然后输入以秒为单位的正整数。请根据实际时间进行调试。

此外,如果不是顶部窗口,则在采集

时将反复单击它。这是因为京东网站上有一些防爬措施,这些措施必须是当前的窗口操作才能生效。因此,请检查该窗口在高级设置中是否可见,并且在采集过程中该窗口将位于顶部。请根据实际情况进行设置。

四、如何将捕获的信息映射到操作步骤?

如果要将捕获的信息与操作步骤一一对应,则必须提取操作对象的信息。有两种方法:

4. 1使用xpath在连续动作的高级设置的内容表达式中找到动作对象的信息节点。

在将定位表达式定位到动作对象的整个操作范围之后,它还收录

其自己的信息。因此,内容表达仅需要从所定位的动作对象开始,并继续对其信息进行定位。采集

时,此步骤的动作信息将记录在与该动作编号对应的动作值中,该动作编号记录了该动作的执行次数。

4. 2在整理框中获取动作对象的信息,这里也使用xpath进行定位。

执行动作对象时,其dom结构将更改。找到网页更改的结构特征,使用xpath精确定位节点,并在通过验证后,可以设置自定义xpath。

以上是使用连续动作来模拟手动操作的整个过程。尽管此过程比较麻烦,但是只要您小心谨慎和耐心地进行,最终就可以征服要爬网的网页。

干货教程:分享一个神器,快速采集文章全靠它!

采集交流 • 优采云 发表了文章 • 0 个评论 • 362 次浏览 • 2020-09-06 17:42

编辑

在流行期间,许多公司不得不选择远程在线办公室。互联网是受流行病影响较小的行业之一,但是远程办公室的效率仍然不如面对面的工作。因此,优采云 采集特别推出了智能采集工具。

我相信许多操作人员已经接触过采集工具。市场上有很多采集工具。许多人认为采集工具仅用作文章热门/节日主题和其他信息采集的辅助工具,实际上,不仅如此。成熟的采集工具不仅可以帮助操作采集信息,而且可以准确地分析数据趋势,从而有助于增加收入。

一、什么是优采云 采集?

优采云 采集是用于自媒体素材搜索,文章 原创一键式发布的操作工具,有效地提高了新媒体运营的效率并降低了公司成本。

二、如何用优采云 采集搜索?

([一)输入关键词

优采云 采集根据用户输入的关键词,通过程序自动进入主流自媒体数据源的搜索引擎进行搜索。

优采云 采集基于高级算法匹配更准确的内容,以提高搜索内容的准确性。

例如:

用户需要采集有关流行病的资料,然后在主页上输入关键词“流行病”。 优采云 采集会将搜索结果合并到一个列表中。

([二)保存搜索材料

优采云 采集具有批量保存搜索资料的功能。

单击[在当前页面上全部选择]功能,然后选中所需的文章,文章将被添加到操作面板中,方便用户批量保存。

([三)精确过滤

1、搜索过滤器

优采云 采集支持根据标题,内容,时间,平台,是否为原创等参数进行过滤,以使搜索内容更加准确。

2、广告过滤 查看全部

快速共享一个工件,采集 文章取决于它!

编辑

在流行期间,许多公司不得不选择远程在线办公室。互联网是受流行病影响较小的行业之一,但是远程办公室的效率仍然不如面对面的工作。因此,优采云 采集特别推出了智能采集工具。

我相信许多操作人员已经接触过采集工具。市场上有很多采集工具。许多人认为采集工具仅用作文章热门/节日主题和其他信息采集的辅助工具,实际上,不仅如此。成熟的采集工具不仅可以帮助操作采集信息,而且可以准确地分析数据趋势,从而有助于增加收入。

一、什么是优采云 采集?

优采云 采集是用于自媒体素材搜索,文章 原创一键式发布的操作工具,有效地提高了新媒体运营的效率并降低了公司成本。

二、如何用优采云 采集搜索?

([一)输入关键词

优采云 采集根据用户输入的关键词,通过程序自动进入主流自媒体数据源的搜索引擎进行搜索。

优采云 采集基于高级算法匹配更准确的内容,以提高搜索内容的准确性。

例如:

用户需要采集有关流行病的资料,然后在主页上输入关键词“流行病”。 优采云 采集会将搜索结果合并到一个列表中。

([二)保存搜索材料

优采云 采集具有批量保存搜索资料的功能。

单击[在当前页面上全部选择]功能,然后选中所需的文章,文章将被添加到操作面板中,方便用户批量保存。

([三)精确过滤

1、搜索过滤器

优采云 采集支持根据标题,内容,时间,平台,是否为原创等参数进行过滤,以使搜索内容更加准确。

2、广告过滤

完美:基于Binlog实时同步数仓,有哪些不为人知的坑?

采集交流 • 优采云 发表了文章 • 0 个评论 • 205 次浏览 • 2020-09-03 17:32

我最近看到了一篇文章文章,该文章主要介绍了基于Flink的MySQL Binlog数据采集的解决方案。在查看了实际的方法和特定的代码操作之后,我感到其中存在一些考虑不周,不足的情况。

作者以前有一些类似的采集工具实践摘要,但没有整体进行系统总结,因此我想知道是否可以编写个人摘要文章,总结Binlog 采集中的问题]以及相应的解决方案?

也许很多人对Binlog不够了解,他们会肤浅地思考:“它不是MySQL生产的,它具有固定的日志结构。将数据采集放入,然后使其成为数据登录。这有什么困难?”

实际上,它实际上是一个日志,但实际上,从场景分析到技术选择的Binlog 采集,整个内部都有很多未知坑,所以请不要小看它。

作者写了这篇文章,目的是展示在实际工作中Binlog数据采集开发过程的原理,注意事项和可能出现的问题,并且还会有一些作者的个人结论。供参考的数据采集中的原则是干货。

一、 Binlog实时采集摘要原则

首先,撇开技术框架的讨论,亲自总结Binlog日志采集的数据的主要原理:

分别解释这三个原理的具体含义。

原则一

在数据采集中,数据着陆通常使用时间分区进行着陆,因此我们需要确定固定的时间戳作为时间划分的基本时间序列。

在这种情况下,业务数据上的时间戳字段似乎是从实际开发中获取此时间戳的角度来看,还是在实际表中将存在此类时间戳的情况下,对于所有表来说都是不可能的完全满足。

举个反例:

表:业务时间戳(或事件时间)

表A:create_time,update_time

表B:create_time

表C:create_at

表D:无

在这种情况下,理论上,可以通过在设计表时限制RD和DBA的表结构的正则化来统一和限制时间戳和命名,但是在实际工作中,这种情况基本上是不可能的。完成,我相信许多读者都会遇到这种情况。

也许很多学习数据采集的学生会认为,我们可以要求他们制定标准吗?

我个人认为是有可能的,但是大数据采集的基础数据不能完全依赖于这种相互建立的标准。

三个原因:

因此,如果要使用唯一的固定时间序列,则必须将其与业务数据分开。我们想要的时间戳不受业务数据更改的影响。

原则二

在业务数据库中,肯定会有表结构更改。在大多数情况下,会添加列,但也有诸如列重命名和列删除之类的情况,并且字段更改的顺序是无法控制的。

此原理要描述的是,导入到数据仓库中的表必须适应数据库表的各种操作,以保持其可用性和列数据的正确性。

原则三

可以追溯此数据,包括两个方面:

第一个描述是,在采集 binlog 采集端,您可以再次按下位置采集 binlog。

第二个描述是,在消费二进制日志登陆结束时,可以使用重复的消费来重新登陆数据。

这是作者的个人总结,无论选择哪种技术进行组合构造,都必须具备这些原则。

二、实施计划和具体操作

技术架构:Debezium + Confluent + Kafka + OSS / S3 + Hive

基于原理一的解决方案

Debezium提供了“新记录状态提取”的配置选项,相当于提供了一个转换运算符来提取binlog中的元数据。

对于0. 10版本的配置,您可以提取Binlog元数据信息,例如表,版本,连接器,名称,ts_ms,db,server_id,文件,pos,行等。

其中ts_ms是binlog日志的生成时间,这是binlog元数据,可以将其应用于所有数据表,并且可以使用此固定时间戳完全实现我们的时间戳,而无需完全了解数据表的内部结构一个。

关于Debezium,不同版本之前的配置参数可能不同。如果读者需要练习,则需要在官方文档中确认相应版本的配置参数。

对于市场上更常用的其他框架(例如Canal),或者如果读者拥有自己的数据采集程序,建议提取所有binlog元数据。可以使用此过程和后续过程。

基于原理二的解决方案

对于Hive而言,当前的主流数据存储格式为Parquet,ORC,Json,Avro。

除了讨论数据存储的效率。

对于前两种数据格式,列存储,也就是说,这两种数据格式的数据读取将严格取决于数据表中数据存储的顺序。该数据格式不符合要求。数据列可以灵活地添加,删除和其他操作。

Avro格式是行存储,但是它需要依赖于模式注册服务。考虑到Hive的数据表读取完全取决于外部服务,因此风险太大。

最后,确定使用Json格式进行数据存储。尽管这种读取和存储效率不如其他格式高,但是它可以确保可以在Hive中读取业务数据中的任何更改。

Debezium组件采集 binlog的数据为json格式,符合预期的设计方案,可以解决由原则2引起的问题。

对于在市场上更常用的诸如Canal之类的其他框架,可以将其设置为Json数据格式进行传输,或者如果读者需要开发自己的data 采集程序,则同样适用。

基于原理三的解决方案

在采集 binlog 采集侧,您可以再次按位置采集 binlog。

官方Debezium 网站也提供了此解决方案的实现。官方的Debezium 网站中也提供了相应的解决方案。为了简要说明,需要使用Kafkacat工具。

对于采集的每个MySQL实例,在创建数据采集任务时,Confluent将相应地创建连接器采集元数据的主题(即采集程序),该主题将存储相应的时间戳,文件位置和位置。您可以通过修改此数据来重置采集 binlog的位置。

值得注意的是,此操作的时间节点也受到限制,这与MySQL Binlog日志保留期有关。因此,以这种方式回溯时,您需要确认MySQL日志仍然存在。

重新登陆数据以重复使用。

该计划是基于Kafka的,并且有很多计划可以在线重新设计Kafka的消费抵消消费网站,因此在此我不再赘述。

对于让读者自己实现它,足以确认所选的MQ支持此功能。

常见问题解答:#how_to_change_the_offsets_of_the_source_database

三、不同的业务场景

本节仅描述如何在作者的技术框架下实施以下操作。读者可以根据自己选择的技术组件探索不同的技术解决方案。

1、数据库子数据库子表情况

基于Debezium的体系结构,一个Source只能对应采集的一个MySQL实例。要在同一实例上拆分表,可以使用Debezium主题路由功能。

采集过滤二进制日志时,请根据常规匹配将与采集对应的表写入指定的主题。

对于子数据库,还需要在接收器侧添加RegexRouter转换运算符,以在主题之间进行合并和写入操作。

2、数据增量采集和总量采集

对于采集组件,当前配置基于增量,因此无论您选择Debezium还是Canal,正常配置都可以。

但是有时在某些情况下需要采集的完整表,而作者也为全部数据采集给出了计划。

计划一:

Debezium本身具有这样的功能,您需要将snapshot.mode参数选择设置为when_needed,以便可以完成表的采集操作总量。

在正式文档中,此处的参数配置有更详细的描述。

快照:#快照

计划二:

同时使用sqoop并增加采集。

此方案适用于表数据已经很多但当前binlog数据频率不高的情况,请使用此方案。

值得注意的是,有两点:

3、离线重复数据删除条件

数据到达后,binlog原创数据通过json表映射出来,然后问题来了,我们如何找到最新的数据?

也许我们可以简单地认为仅使用提取的ts_ms然后进行反演是不够的?

在大多数情况下,这确实是可能的。但是,在实际开发中,作者发现这种情况不能满足所有情况,因为在binlog中,可能有两个与ts_ms和PK相同但确实不同的数据。

那我们如何同时解决两个数据呢?答案就在上面,我们只是建议提取所有binlog元数据。

选择*

从

(

SELECT *,

row_number()over(按t.id分区或按t.`__ts_ms` DESC,t.`__file` DESC,cast(t.`__pos` AS int)DESC)按order_by

FROM测试t

哪里dt ='{pt}'

AND hour ='{now_hour}'

)t1

其中t 1. order_by = 1

在此sql中解释row_number的条件:

通过这种条件组合得出的数据是最新的。

一些读者可能会问,如果删除了这部分数据该怎么办?这样检索到的数据不是错误的吗?

此Debezium也具有相应的操作,并且具有相应的配置选项供您选择如何处理删除行为的binlog数据。

作为所有人的参考,作者选择了rewrite的参数配置,因此在上面sql的最外层中,仅需要判断“ delete ='false'”是正确的数据。

Debezium:

四、体系结构摘要

在选择技术以及整体和详细结构时,作者始终坚持原则-过程尽可能简单而不是尽可能简单。数据链接越长,链接可能出现的问题就越多。对于以后的锁定问题以及操作和维护,难度将很高。

因此,作者在技术选择中也考虑了Flink + Kafka方法,但是基于当时的现状,作者没有选择这种技术选择,并且作者还将说明原因。

1)作者的Flink环境尚未针对开发,操作和维护进行平台化。

2)场景偏向于数据采集和传输而不是计算,并且Flink的优势不多。

3)如果您基于MySQL实例开发Flink程序并使用本机Flink Steaming进行api风格的程序开发,如果该程序由于某些表中的数据而挂起,则该实例中的数据将不会可用采集这种影响的范围太大。

4)如果您基于表制作Flink程序或以常规方式匹配某些表,尽管可以保证灵活性,但是90%的代码是多余的,将有许多任务。浪费资源。

5)最后一个问题是开发和维护的效率。如果仅编写本机Flink程序,则随后的累积开发将使该程序越来越重,并且逻辑可能变得越来越麻烦。

总而言之,我当时想到了Flink。如果Flink并非基于平台进行开发,运行和维护监控,则可以将其用作临时解决方案。但是,如果Flink在以后的开发过程中被缝制和修复,那么在人类的开发下会出现更多的问题,或者每个人都在这样的程序框架下构建轮子,并且它们构建的越多,速度就越慢。而且,后期的主要项目方向并未将Flink平台化提上议事日程,因此考虑到某些未来条件也是一种选择。

因此,当我最终决定选择技术时,我没有选择Flink。

五、结论

本文的作者更具理论性,也是该方案的技术思想的摘要。技术架构方案有很多种。我只是选择其中之一进行实施。我也希望您有其他交流的技术方案或理论。请纠正我。

作者丨李楠来源丨数据仓库和Python大数据(ID:dw_zzxx)dbaplus社区欢迎技术人员的贡献。贡献电子邮件: 查看全部

基于Binlog实时同步数据仓库,未知坑是什么?

我最近看到了一篇文章文章,该文章主要介绍了基于Flink的MySQL Binlog数据采集的解决方案。在查看了实际的方法和特定的代码操作之后,我感到其中存在一些考虑不周,不足的情况。

作者以前有一些类似的采集工具实践摘要,但没有整体进行系统总结,因此我想知道是否可以编写个人摘要文章,总结Binlog 采集中的问题]以及相应的解决方案?

也许很多人对Binlog不够了解,他们会肤浅地思考:“它不是MySQL生产的,它具有固定的日志结构。将数据采集放入,然后使其成为数据登录。这有什么困难?”

实际上,它实际上是一个日志,但实际上,从场景分析到技术选择的Binlog 采集,整个内部都有很多未知坑,所以请不要小看它。

作者写了这篇文章,目的是展示在实际工作中Binlog数据采集开发过程的原理,注意事项和可能出现的问题,并且还会有一些作者的个人结论。供参考的数据采集中的原则是干货。

一、 Binlog实时采集摘要原则

首先,撇开技术框架的讨论,亲自总结Binlog日志采集的数据的主要原理:

分别解释这三个原理的具体含义。

原则一

在数据采集中,数据着陆通常使用时间分区进行着陆,因此我们需要确定固定的时间戳作为时间划分的基本时间序列。

在这种情况下,业务数据上的时间戳字段似乎是从实际开发中获取此时间戳的角度来看,还是在实际表中将存在此类时间戳的情况下,对于所有表来说都是不可能的完全满足。

举个反例:

表:业务时间戳(或事件时间)

表A:create_time,update_time

表B:create_time

表C:create_at

表D:无

在这种情况下,理论上,可以通过在设计表时限制RD和DBA的表结构的正则化来统一和限制时间戳和命名,但是在实际工作中,这种情况基本上是不可能的。完成,我相信许多读者都会遇到这种情况。

也许很多学习数据采集的学生会认为,我们可以要求他们制定标准吗?

我个人认为是有可能的,但是大数据采集的基础数据不能完全依赖于这种相互建立的标准。

三个原因:

因此,如果要使用唯一的固定时间序列,则必须将其与业务数据分开。我们想要的时间戳不受业务数据更改的影响。

原则二

在业务数据库中,肯定会有表结构更改。在大多数情况下,会添加列,但也有诸如列重命名和列删除之类的情况,并且字段更改的顺序是无法控制的。

此原理要描述的是,导入到数据仓库中的表必须适应数据库表的各种操作,以保持其可用性和列数据的正确性。

原则三

可以追溯此数据,包括两个方面:

第一个描述是,在采集 binlog 采集端,您可以再次按下位置采集 binlog。

第二个描述是,在消费二进制日志登陆结束时,可以使用重复的消费来重新登陆数据。

这是作者的个人总结,无论选择哪种技术进行组合构造,都必须具备这些原则。

二、实施计划和具体操作

技术架构:Debezium + Confluent + Kafka + OSS / S3 + Hive

基于原理一的解决方案

Debezium提供了“新记录状态提取”的配置选项,相当于提供了一个转换运算符来提取binlog中的元数据。

对于0. 10版本的配置,您可以提取Binlog元数据信息,例如表,版本,连接器,名称,ts_ms,db,server_id,文件,pos,行等。

其中ts_ms是binlog日志的生成时间,这是binlog元数据,可以将其应用于所有数据表,并且可以使用此固定时间戳完全实现我们的时间戳,而无需完全了解数据表的内部结构一个。

关于Debezium,不同版本之前的配置参数可能不同。如果读者需要练习,则需要在官方文档中确认相应版本的配置参数。

对于市场上更常用的其他框架(例如Canal),或者如果读者拥有自己的数据采集程序,建议提取所有binlog元数据。可以使用此过程和后续过程。

基于原理二的解决方案

对于Hive而言,当前的主流数据存储格式为Parquet,ORC,Json,Avro。

除了讨论数据存储的效率。

对于前两种数据格式,列存储,也就是说,这两种数据格式的数据读取将严格取决于数据表中数据存储的顺序。该数据格式不符合要求。数据列可以灵活地添加,删除和其他操作。

Avro格式是行存储,但是它需要依赖于模式注册服务。考虑到Hive的数据表读取完全取决于外部服务,因此风险太大。

最后,确定使用Json格式进行数据存储。尽管这种读取和存储效率不如其他格式高,但是它可以确保可以在Hive中读取业务数据中的任何更改。

Debezium组件采集 binlog的数据为json格式,符合预期的设计方案,可以解决由原则2引起的问题。

对于在市场上更常用的诸如Canal之类的其他框架,可以将其设置为Json数据格式进行传输,或者如果读者需要开发自己的data 采集程序,则同样适用。

基于原理三的解决方案

在采集 binlog 采集侧,您可以再次按位置采集 binlog。

官方Debezium 网站也提供了此解决方案的实现。官方的Debezium 网站中也提供了相应的解决方案。为了简要说明,需要使用Kafkacat工具。

对于采集的每个MySQL实例,在创建数据采集任务时,Confluent将相应地创建连接器采集元数据的主题(即采集程序),该主题将存储相应的时间戳,文件位置和位置。您可以通过修改此数据来重置采集 binlog的位置。

值得注意的是,此操作的时间节点也受到限制,这与MySQL Binlog日志保留期有关。因此,以这种方式回溯时,您需要确认MySQL日志仍然存在。

重新登陆数据以重复使用。

该计划是基于Kafka的,并且有很多计划可以在线重新设计Kafka的消费抵消消费网站,因此在此我不再赘述。

对于让读者自己实现它,足以确认所选的MQ支持此功能。

常见问题解答:#how_to_change_the_offsets_of_the_source_database

三、不同的业务场景

本节仅描述如何在作者的技术框架下实施以下操作。读者可以根据自己选择的技术组件探索不同的技术解决方案。

1、数据库子数据库子表情况

基于Debezium的体系结构,一个Source只能对应采集的一个MySQL实例。要在同一实例上拆分表,可以使用Debezium主题路由功能。

采集过滤二进制日志时,请根据常规匹配将与采集对应的表写入指定的主题。

对于子数据库,还需要在接收器侧添加RegexRouter转换运算符,以在主题之间进行合并和写入操作。

2、数据增量采集和总量采集

对于采集组件,当前配置基于增量,因此无论您选择Debezium还是Canal,正常配置都可以。

但是有时在某些情况下需要采集的完整表,而作者也为全部数据采集给出了计划。

计划一:

Debezium本身具有这样的功能,您需要将snapshot.mode参数选择设置为when_needed,以便可以完成表的采集操作总量。

在正式文档中,此处的参数配置有更详细的描述。

快照:#快照

计划二:

同时使用sqoop并增加采集。

此方案适用于表数据已经很多但当前binlog数据频率不高的情况,请使用此方案。

值得注意的是,有两点:

3、离线重复数据删除条件

数据到达后,binlog原创数据通过json表映射出来,然后问题来了,我们如何找到最新的数据?

也许我们可以简单地认为仅使用提取的ts_ms然后进行反演是不够的?

在大多数情况下,这确实是可能的。但是,在实际开发中,作者发现这种情况不能满足所有情况,因为在binlog中,可能有两个与ts_ms和PK相同但确实不同的数据。

那我们如何同时解决两个数据呢?答案就在上面,我们只是建议提取所有binlog元数据。

选择*

从

(

SELECT *,

row_number()over(按t.id分区或按t.`__ts_ms` DESC,t.`__file` DESC,cast(t.`__pos` AS int)DESC)按order_by

FROM测试t

哪里dt ='{pt}'

AND hour ='{now_hour}'

)t1

其中t 1. order_by = 1

在此sql中解释row_number的条件:

通过这种条件组合得出的数据是最新的。

一些读者可能会问,如果删除了这部分数据该怎么办?这样检索到的数据不是错误的吗?

此Debezium也具有相应的操作,并且具有相应的配置选项供您选择如何处理删除行为的binlog数据。

作为所有人的参考,作者选择了rewrite的参数配置,因此在上面sql的最外层中,仅需要判断“ delete ='false'”是正确的数据。

Debezium:

四、体系结构摘要

在选择技术以及整体和详细结构时,作者始终坚持原则-过程尽可能简单而不是尽可能简单。数据链接越长,链接可能出现的问题就越多。对于以后的锁定问题以及操作和维护,难度将很高。

因此,作者在技术选择中也考虑了Flink + Kafka方法,但是基于当时的现状,作者没有选择这种技术选择,并且作者还将说明原因。

1)作者的Flink环境尚未针对开发,操作和维护进行平台化。

2)场景偏向于数据采集和传输而不是计算,并且Flink的优势不多。

3)如果您基于MySQL实例开发Flink程序并使用本机Flink Steaming进行api风格的程序开发,如果该程序由于某些表中的数据而挂起,则该实例中的数据将不会可用采集这种影响的范围太大。

4)如果您基于表制作Flink程序或以常规方式匹配某些表,尽管可以保证灵活性,但是90%的代码是多余的,将有许多任务。浪费资源。

5)最后一个问题是开发和维护的效率。如果仅编写本机Flink程序,则随后的累积开发将使该程序越来越重,并且逻辑可能变得越来越麻烦。

总而言之,我当时想到了Flink。如果Flink并非基于平台进行开发,运行和维护监控,则可以将其用作临时解决方案。但是,如果Flink在以后的开发过程中被缝制和修复,那么在人类的开发下会出现更多的问题,或者每个人都在这样的程序框架下构建轮子,并且它们构建的越多,速度就越慢。而且,后期的主要项目方向并未将Flink平台化提上议事日程,因此考虑到某些未来条件也是一种选择。

因此,当我最终决定选择技术时,我没有选择Flink。

五、结论

本文的作者更具理论性,也是该方案的技术思想的摘要。技术架构方案有很多种。我只是选择其中之一进行实施。我也希望您有其他交流的技术方案或理论。请纠正我。

作者丨李楠来源丨数据仓库和Python大数据(ID:dw_zzxx)dbaplus社区欢迎技术人员的贡献。贡献电子邮件:

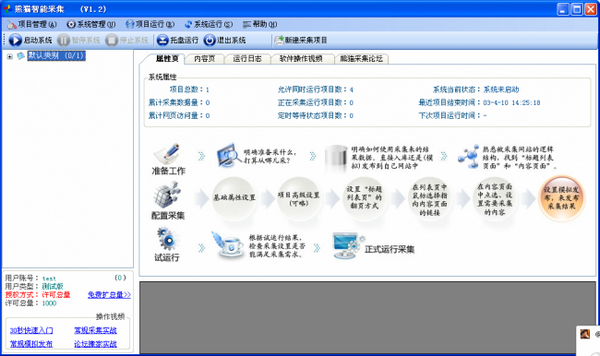

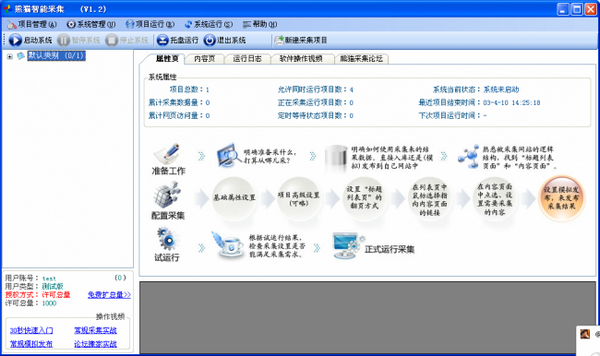

整套解决方案:熊猫智能采集软件破解版软件特色

采集交流 • 优采云 发表了文章 • 0 个评论 • 586 次浏览 • 2020-08-30 12:08

软件介绍

熊猫智能采集软件破解版是一款功能强悍的网路采集工具,用户可以通过可视化的键盘进行操作,让用户无需关心网页源码,无需对采集规则进行编撰,无需使用表达式技术,就可使用户对浏览器里的内容进行采集,并且为用户提供自由组合的功能方式,使得用户可以方便、高效的实现不同采集需求。

熊猫智能采集软件破解版软件特色

1.操作简单,不懂技术亦可轻松操作

简单到只须要输入列表页网址或关键词即可开始采集。不需要关心网页源码,全程键盘操作。熊猫智能采集软件测试版操作界面友好直观。全程智能辅助。

2.功能全面、强大

软件即使操作简单,却功能强悍、全面。可以实现各种复杂采集需求。可应用于各类场合的通用性采集软件。是复杂采集需求的首先。

3.任何网页都可以采集

只要你能在浏览器中可以听到的内容,几乎都可以按你须要的格式进行采集。支持JS输出内容的采集。

4.采集速度快,数据完整度高

熊猫的采集速度是采集软件中速率最快的之一。独有的多模板功能+智能纠错模式,可以确保结果数据100%完整。

5.全方位的采集功能

浏览器可见的内容都可以采集。采集的对象包括文字内容,图片,flash动漫视频等等各种网路内容。支持图文混排对象的同时采集。

6.面向对象的采集方式

面向对象的采集方式。正文和回复内容同时采集的能力,分页的内容可轻松合并,采集内容可以是分散在多个页面内。结果可以是复杂的兄妹表结构。

7.采集速度快

优采云采集器的采集速度是采集软件中最快的(之一)。不使用落后低效的正则匹配技术。也不使用第三方外置浏览器访问的技术。使用自己研制的解析引擎。

8.结果数据完整度高

熊猫独有的多模板功能,确保结果数据完整不遗漏。独有的智能纠错模式,可以手动纠正模板和目标页面的不一致。

熊猫智能采集软件破解版软件功能

一键采集

输入采集入口网址就可以完成设置开始采集,输入关键词即可全网搜索采集。

云端采集

独有的基于对等网构架的云采集功能,可以解决采集时被封IP的业界困局。

多模板自适应

一个项目可以配置多个模板,运行时软件手动选择最合适的模板来进行采集匹配。

万能的模拟发布

无需开发针对性的发布插口文件,可以适应任何网站CMS后台,利用人工发布页面,来模拟人工发布。

内容的相似度判定

基于内容相似度来判定文章的重复性,准确率高。可以列举相像文章列表,可以输出文章核心关键词。

支持复杂数据关系

支持姐弟结构的数据逻辑关系。复杂的数据,一次性完整采集,采集结果保留原数据的逻辑关系。

熊猫智能采集软件破解版软件评测

功能全面、强大、软件即使操作简单,却功能强悍、全面。可以实现各种复杂采集需求。可应用于各类场合的通用性采集软件

不懂技术亦可轻松操作、不需要编撰采集规则,不需要关心网页源码,全程键盘操作。操作界面友好、直观。全程智能辅助。且不用害怕设置的采集会频繁失效。

解决复杂采集需求、熊猫独有的面向对象采集功能,父子表功能,多模板功能,嵌套多列表页一次访问功能等等,可以使你轻松应付各种复杂数据关系的场合。

搜索引擎解析内核、利用智能搜索引擎的解析内核,实现对采集网页的仿浏览器解析。拥有自成体系的多项核心关键技术。

强大的手动剖析能力、系统可手动剖析翻页、分页、页面标题、正文等。可以对搜索引擎的搜索结果实现手动解析。

熊猫智能采集软件破解版使用教程

1、打开软件,在安装完成的时侯勾选立刻运行软件,或者使用键盘双击桌面快捷方法打开软件即可,打开软件以后用户将会看见如下画面

2、账号登入,用户在帐号登入界面输入自己的帐号以及帐号密码进行登陆

3、账号注册,没有帐号难以进行登陆的用户可以点击登陆界面的帐号注册进行帐号的注册使用

4、找回密码,用户在忘掉或则想要更改密码的时侯可以点击登陆界面的寻回密码字样进行密码的更改

5、账号注册流程,用户点击注册帐号以后,使用浏览器打开,软件将会跳转到如下界面,用户按照提示输入信息即可完成注册

6、找回密码流程,用户在登入界面点击了寻回密码以后,系统将会跳转到如下界面,用户输入自己的帐号信息即可完成密码的更改

7、启动系统,用户点击主界面的右上角的启动系统字样即可启动软件系统使用,同时也有暂停,停止系统的功能在其左侧

8、托盘运行,用户点击托盘运行,软件将会手动最小化到托盘,不再继续在桌面上显示

9、退出系统,用户点击退出系统,软件将会直接关掉,用户须要重新打开方可继续使用

10、新建项目的标准,用户须要输入项目的名称,设置项目的位置,选择网站编码以及一系列的参数设置,点击确认即可完成

11、项目的名称、可以是任意字符,可以重名,可以随时更改、项目名称只起标识作用,方便用户管理项目,但不影响项目的设置和运行、理论上可以为空,但不推荐。

12、项目运行,项目运行(R)、启动该项目、运行该项目、暂停该项目、停止该项目、批量启动项目、批量运行项目、批量暂停项目、批量停止项目、开始发布数据、停止发布数据

13、用户点击界面上方的系统运行即可使用相应的功能:系统运行(S)、启动系统、暂停运行、停止运行、退出系统

熊猫智能采集软件破解版常见问题

如何用优采云采集器器实现网路上电话号码的搜索采集

介绍怎样使用软件自带的采集模板,实现对主流网站的电话号码的采集。只须要简单的几步,填写必要的搜索关键词和选择搜索的地区,即可开始采集。——过程十分简单,已简单到难以再简单了。

如何用熊猫软件快速采集客户信息并添加陌陌好友操作说明

应广大用户要求,制作了一个采集电话号码后,如何批量导出到陌陌中的帮助文档。

如何实现招投标信息的采集监测监控

利用熊猫智能采集监测引擎,可以轻松实现对招标信息发布网站的最新招标信息进行检测。优采云采集器,是招标信息检测软件的最优选择:操作容易、维护简单、结果直观便捷。

如何实现对标题列表页内容的直接采集

部分场合下,可能须要对标题列表页中链接所辖内容的采集,此案例对此作了详尽的操作演示。灵活借助熊猫的中级设置功能,可以应付各种复杂的采集需求场合。

熊猫智能采集软件破解版更新日志

修复多个BUG 查看全部

熊猫智能采集软件破解版软件特色

软件介绍

熊猫智能采集软件破解版是一款功能强悍的网路采集工具,用户可以通过可视化的键盘进行操作,让用户无需关心网页源码,无需对采集规则进行编撰,无需使用表达式技术,就可使用户对浏览器里的内容进行采集,并且为用户提供自由组合的功能方式,使得用户可以方便、高效的实现不同采集需求。

熊猫智能采集软件破解版软件特色

1.操作简单,不懂技术亦可轻松操作

简单到只须要输入列表页网址或关键词即可开始采集。不需要关心网页源码,全程键盘操作。熊猫智能采集软件测试版操作界面友好直观。全程智能辅助。

2.功能全面、强大

软件即使操作简单,却功能强悍、全面。可以实现各种复杂采集需求。可应用于各类场合的通用性采集软件。是复杂采集需求的首先。

3.任何网页都可以采集

只要你能在浏览器中可以听到的内容,几乎都可以按你须要的格式进行采集。支持JS输出内容的采集。

4.采集速度快,数据完整度高

熊猫的采集速度是采集软件中速率最快的之一。独有的多模板功能+智能纠错模式,可以确保结果数据100%完整。

5.全方位的采集功能

浏览器可见的内容都可以采集。采集的对象包括文字内容,图片,flash动漫视频等等各种网路内容。支持图文混排对象的同时采集。

6.面向对象的采集方式

面向对象的采集方式。正文和回复内容同时采集的能力,分页的内容可轻松合并,采集内容可以是分散在多个页面内。结果可以是复杂的兄妹表结构。

7.采集速度快

优采云采集器的采集速度是采集软件中最快的(之一)。不使用落后低效的正则匹配技术。也不使用第三方外置浏览器访问的技术。使用自己研制的解析引擎。

8.结果数据完整度高

熊猫独有的多模板功能,确保结果数据完整不遗漏。独有的智能纠错模式,可以手动纠正模板和目标页面的不一致。

熊猫智能采集软件破解版软件功能

一键采集

输入采集入口网址就可以完成设置开始采集,输入关键词即可全网搜索采集。

云端采集

独有的基于对等网构架的云采集功能,可以解决采集时被封IP的业界困局。

多模板自适应

一个项目可以配置多个模板,运行时软件手动选择最合适的模板来进行采集匹配。

万能的模拟发布

无需开发针对性的发布插口文件,可以适应任何网站CMS后台,利用人工发布页面,来模拟人工发布。

内容的相似度判定

基于内容相似度来判定文章的重复性,准确率高。可以列举相像文章列表,可以输出文章核心关键词。

支持复杂数据关系

支持姐弟结构的数据逻辑关系。复杂的数据,一次性完整采集,采集结果保留原数据的逻辑关系。

熊猫智能采集软件破解版软件评测

功能全面、强大、软件即使操作简单,却功能强悍、全面。可以实现各种复杂采集需求。可应用于各类场合的通用性采集软件

不懂技术亦可轻松操作、不需要编撰采集规则,不需要关心网页源码,全程键盘操作。操作界面友好、直观。全程智能辅助。且不用害怕设置的采集会频繁失效。

解决复杂采集需求、熊猫独有的面向对象采集功能,父子表功能,多模板功能,嵌套多列表页一次访问功能等等,可以使你轻松应付各种复杂数据关系的场合。

搜索引擎解析内核、利用智能搜索引擎的解析内核,实现对采集网页的仿浏览器解析。拥有自成体系的多项核心关键技术。

强大的手动剖析能力、系统可手动剖析翻页、分页、页面标题、正文等。可以对搜索引擎的搜索结果实现手动解析。

熊猫智能采集软件破解版使用教程

1、打开软件,在安装完成的时侯勾选立刻运行软件,或者使用键盘双击桌面快捷方法打开软件即可,打开软件以后用户将会看见如下画面

2、账号登入,用户在帐号登入界面输入自己的帐号以及帐号密码进行登陆

3、账号注册,没有帐号难以进行登陆的用户可以点击登陆界面的帐号注册进行帐号的注册使用

4、找回密码,用户在忘掉或则想要更改密码的时侯可以点击登陆界面的寻回密码字样进行密码的更改

5、账号注册流程,用户点击注册帐号以后,使用浏览器打开,软件将会跳转到如下界面,用户按照提示输入信息即可完成注册

6、找回密码流程,用户在登入界面点击了寻回密码以后,系统将会跳转到如下界面,用户输入自己的帐号信息即可完成密码的更改

7、启动系统,用户点击主界面的右上角的启动系统字样即可启动软件系统使用,同时也有暂停,停止系统的功能在其左侧

8、托盘运行,用户点击托盘运行,软件将会手动最小化到托盘,不再继续在桌面上显示

9、退出系统,用户点击退出系统,软件将会直接关掉,用户须要重新打开方可继续使用

10、新建项目的标准,用户须要输入项目的名称,设置项目的位置,选择网站编码以及一系列的参数设置,点击确认即可完成

11、项目的名称、可以是任意字符,可以重名,可以随时更改、项目名称只起标识作用,方便用户管理项目,但不影响项目的设置和运行、理论上可以为空,但不推荐。

12、项目运行,项目运行(R)、启动该项目、运行该项目、暂停该项目、停止该项目、批量启动项目、批量运行项目、批量暂停项目、批量停止项目、开始发布数据、停止发布数据

13、用户点击界面上方的系统运行即可使用相应的功能:系统运行(S)、启动系统、暂停运行、停止运行、退出系统

熊猫智能采集软件破解版常见问题

如何用优采云采集器器实现网路上电话号码的搜索采集

介绍怎样使用软件自带的采集模板,实现对主流网站的电话号码的采集。只须要简单的几步,填写必要的搜索关键词和选择搜索的地区,即可开始采集。——过程十分简单,已简单到难以再简单了。

如何用熊猫软件快速采集客户信息并添加陌陌好友操作说明

应广大用户要求,制作了一个采集电话号码后,如何批量导出到陌陌中的帮助文档。

如何实现招投标信息的采集监测监控

利用熊猫智能采集监测引擎,可以轻松实现对招标信息发布网站的最新招标信息进行检测。优采云采集器,是招标信息检测软件的最优选择:操作容易、维护简单、结果直观便捷。

如何实现对标题列表页内容的直接采集

部分场合下,可能须要对标题列表页中链接所辖内容的采集,此案例对此作了详尽的操作演示。灵活借助熊猫的中级设置功能,可以应付各种复杂的采集需求场合。

熊猫智能采集软件破解版更新日志

修复多个BUG

真相:人工智能与新闻写作机器人

采集交流 • 优采云 发表了文章 • 0 个评论 • 280 次浏览 • 2020-08-29 05:05

转发本文到任意有关华南理工新传考研的群组,联系【华工小传】个人陌陌即可申领华工老师论文合辑!

一、当前新闻写作机器人的发展概况

新闻机器人,或者叫AI机器人。是人工智能在新闻领域的最新应用。其实,在‘‘九寨沟强震”出现机器人新闻曾经,新闻机器人就已被世界上的主流媒体所关注并加以使用。例如,国外有路透社的WordSmith,华盛顿邮报的Heliograf以及纽约时报的blossom等。国内则有新华社的快笔小新、腾讯的dreamwriter、第一财经的DT稿王等。这些写稿机器人无一例外都运用到了大数据处理技术。首先通过数据采集,将其录入数据库中,在将这种数据根据句子出现频度以及新闻要素关键词进行剖析加工。制作出一套符合该媒体发稿风格的糢板,然后将新闻元素5W1H代入其中,一篇新闻消息就这样形成了。

二、机器人写稿的优势

提升发稿速率,全天候新闻热点检测,提高新闻的时效性

时间对于新闻的意义非同小可,尤其是在当前网路新闻环境之下.可谓是分秒必争。新闻机器人通过之前学习相像稿件的写作模式,凭借其快速的信息处理能力,可以在极短的吋间内就与出一篇符合该媒体写作风格的作品。

新闻愈发全面,互联网端新闻报导的长尾效应突出

在互联网平台上新闻报导的长尾效应非常突出,即因为受众基数巨大,即使冷门用户其数目也非常可观。同吋基于互联网平台的新闻传播对个性化新闻需求的满足也有利于用户粘性的增速。这也符合未来订制新闻,分众化新闻的大趋势。

使记者从快新闻中解脱下来.着力对深度新闻的构建

当前,新闻消息的生成和传播速率越来越快,新闻的时效性也要求越来越高,但与之相对的贝『新闻消息的影响力却大不如前。一方面.新闻的半袞期越来越短,另一方面快餐式的新闻参杂网路.媒体行业的激烈竞争促使记者疲于应付千篇一律的消息,即便这么,漏题现象也时有发生。在那些消息上使用机器人写作,使得记者可以从疲于奔命式的抢新闻中解脱下来.对风波背后的新闻线索进行深入挖掘和批判性地思索。从长远看来,深度报导对新闻界是有百利而无一害,甚至可以使快新闻渐渐慢下来,也给与读者思索与品读的时间。

面对巨大数据量处理时降低出错量

对于经济、体育类的新闻,常常有许多数字.数据须要整理汇总。人类记者在处理这种数字、图表时,常常由于数据量大而忙中出错.但是,机器人凭着其强悍的运算能力,可以处理海量数据,且不容易出错。

不带有个人情感.文章更加客观

机器人新闻小带有任何人类情感,文章的生成完全依赖于数据。比如在比赛汇总上,不会由于喜爱某支球员而厚此薄彼。而是严格依照数据,客观地陈述事实。在某种程度上,机器人新闻更接近新闻上对客观性的要求。

媒体对“新闻机器人”的报导

三、目前机器人写稿存在的问题

机器人对信息的深度理解不够

新闻机器人所能做的只是在现有数据库的支持下,对文章进行词汇和句子的抓取,然后进行排列组合,就像在进行一个复杂的填字游戏那样。机器人对文章的深度理解能力还远远不能与人类相提并论。虽然身为第二代新闻机器人,在语义理解上仍具有很大缺陷。但随着机器学习能力的不断提升.相信这些低级错误是完全可以避免的。

扁平化新闻千篇一律,缺乏亮点和重点

对信息的提炼和概括能力不足

要想把一篇文章写好,对信息的概括和提炼能力是一个记者必备的职业素质,长而空洞的文章是没有人看的。但目前的写作机器人其实没有提炼和概括的能力,提炼与概括的前提是理解,机器人对于人类语言的理解能力还非常弱,这就限制了机器人写作的文章体裁和领域。

写作领域较为单一,目前局限为财经和体育

机器人新闻当前的应用还逗留在以使用数据为主的新闻领域。具体的说是在财经和体育方面。主要工作是年度财报新闻以及比赛新闻。而且大部分的新闻机器人都较为单一的从事某一领域的写作。很少能“身兼数职”、“一机多能”。这一方面是因为其初始写作模块的设置,功能较为单一,未能考虑到深读学习功能:另一方面.数据壁垒的造成其不能获取学习更多的数据资料,导致其”知之很少”.

四、未来机器人新闻的未来发展方向

跨领域的多面手

目前来看.新闻机器人的写作能力还仅仅逗留在某一领域。一方面,现有的机器人写手不象人类一样.可以眼观六路耳听八方,它的处理器能力还挺单.。交叉数据的处理能力太弱。其次,数据库的开源也是阻碍新闻机器人跨领域上作的一个障碍.机器人写手只有接入到相应的数据库中能够继续进行剖析数据,加工模板.再套用写作。不同数据库之间的开源以及数据的整合促使机器人的跨领域写作有一定阻力。因此,像新华网的快笔小新.它似乎是有3个分身,每个分身各处理一个领域的新闻消息。但是,机器人的发展不可能局限于某一领域。随着其数据处理能力的提高,以及数据开源成为可能.跨领域的机器人新闻写作将成为可能,这样一来,不仅大大节省了成本,而且写出的稿件将愈发全面,不同数据库的资料可以互相补充.取长补短。写作的类型也将不仅仅局限于短消息。使得人物通信.甚至时政评论成为可能。

人类记者、編辑的助手

将来的新闻编辑部太可能出现二加一的局面,即机器人记者同人类记者撰稿,机器人编辑同编辑共同初审把关。机器人记者可以对大量文本,音视频数据进行处理,形成报导提纲或数据图表,经过一轮对数据的加工,使得记者省去了查阅资料,整理汇总的不便,对报导重心做到心小有数.下笔有神。同时,可以协助编辑校对文稿.并快速发布到各媒体终端。

平等的交流者

目前为止.写作机器人还逗留在单向度的接受指令,进行运算的层面。也就是说机器人还只能逗留在辅助记者工作的阶段。但相信在不久的将来,随着数据量的增多,机器的运算能力的降低.以及机器对于自然语言理解能力的提高,机器人可以平等地同人类进行交流,对人类的意见进行反馈建议。

多平台终端、数据库资源的连通者

未来随着各机构数据库、不问平台之间的不断开源,新闻机器人可以实现“推”与“拉’’ 的多平台终端,数据库资源连通。一方面可以将写好的稿件快速同时上传到多个媒体平台,例如近日机器人小明可以将所写明日头条的稿件白动共享到微博平台:另一方面,将不同数据库连通上去:使得数据交叉整合,发挥更大的效能。

媒介融合的推动者

新闻机器人小明在此次亚运新闻报导中加入了图象辨识,可以选购出合适的赛事画面作为文章配图。在今后的发展中机器人甚至可以将视频、音频甚至虚拟现实技术整合上去。实现真正地媒介融合。新闻机器人和可能是今后媒介融合的一个具体产物,它出现在新闻现场,根据新闻对象须要,安装相应的新闻模块,装配虚拟现实摄像头,可以快速写稿、现场直播,制作VR作品.未来的新闻机器人发展的可能性是无限的。

小传点题

个性化新闻推送对新闻生产机制、受众的塑造与发展策略

一、对新闻生产机制的塑造

新闻生产的智能化数据驱动范式:数据引擎成为内容“标配”:瀲活“长尾内容”,满足用户的小众化需求

新闻内容分发成为专业化的独立部门.:集社交、搜索,场景辨识,个性化推送、智能化聚合于一体

二、对受众的塑造

个性化新闻推送之利:有助于“使用与满足”范式下用户地位的升级

个性化新闻推送之弊:易引起用户信息消费的固化和“信息茧房”效应的形成

三、个性化新闻推送机制未来的发展进路与技术重点

走出“茧房”效应:基于用户的社交数据和相关关系“定义”潜在需求

“聊新闻”:基于人工智能的人机交互模式可以对个性化精准信息服务起到扩张和挖掘作用

连接物联网:用户获取的不单单是简单的新闻资讯:而是一整套相关的配套服务,信息获取平台也弄成一个实现精准服务的超内容社区

【课程类型 】 全程班

【时间】2018年4月至12月

四月至暑期前期以新闻学传播学为主,基本囊括了823和440的全部考点,更偏向基础知识的考察,帮助你们筑牢基础,更好的应对二期的拔高。进入假期开始全科学习,针对简答、论述题题训练,总结热点风波,把握华工考察方向,帮助提升分数,提高应试能力,系统讲解答题方法和答题方法。十一月开始系统模拟,考场全仿真,让你出场不慌,考场有底。

每次讲解完后会按照课程进行当堂检查,帮助你们更好理解新学知识。

课下作业可以引导你们的备考方向和练习角度。

不定期进行模拟考帮助了解对知识的把握程度和个人排行。

小班制,答疑

赠送纸质备考资料、课程资料、模拟试题,赠送价值199的模拟试卷答疑班

预报考或订购补习资料的朋友专享价:999三月一日后恢复原价1099

长按关注下方二维码,提前步入华工新传加油站! 查看全部

人工智能与新闻写作机器人

转发本文到任意有关华南理工新传考研的群组,联系【华工小传】个人陌陌即可申领华工老师论文合辑!

一、当前新闻写作机器人的发展概况

新闻机器人,或者叫AI机器人。是人工智能在新闻领域的最新应用。其实,在‘‘九寨沟强震”出现机器人新闻曾经,新闻机器人就已被世界上的主流媒体所关注并加以使用。例如,国外有路透社的WordSmith,华盛顿邮报的Heliograf以及纽约时报的blossom等。国内则有新华社的快笔小新、腾讯的dreamwriter、第一财经的DT稿王等。这些写稿机器人无一例外都运用到了大数据处理技术。首先通过数据采集,将其录入数据库中,在将这种数据根据句子出现频度以及新闻要素关键词进行剖析加工。制作出一套符合该媒体发稿风格的糢板,然后将新闻元素5W1H代入其中,一篇新闻消息就这样形成了。

二、机器人写稿的优势

提升发稿速率,全天候新闻热点检测,提高新闻的时效性

时间对于新闻的意义非同小可,尤其是在当前网路新闻环境之下.可谓是分秒必争。新闻机器人通过之前学习相像稿件的写作模式,凭借其快速的信息处理能力,可以在极短的吋间内就与出一篇符合该媒体写作风格的作品。

新闻愈发全面,互联网端新闻报导的长尾效应突出

在互联网平台上新闻报导的长尾效应非常突出,即因为受众基数巨大,即使冷门用户其数目也非常可观。同吋基于互联网平台的新闻传播对个性化新闻需求的满足也有利于用户粘性的增速。这也符合未来订制新闻,分众化新闻的大趋势。

使记者从快新闻中解脱下来.着力对深度新闻的构建

当前,新闻消息的生成和传播速率越来越快,新闻的时效性也要求越来越高,但与之相对的贝『新闻消息的影响力却大不如前。一方面.新闻的半袞期越来越短,另一方面快餐式的新闻参杂网路.媒体行业的激烈竞争促使记者疲于应付千篇一律的消息,即便这么,漏题现象也时有发生。在那些消息上使用机器人写作,使得记者可以从疲于奔命式的抢新闻中解脱下来.对风波背后的新闻线索进行深入挖掘和批判性地思索。从长远看来,深度报导对新闻界是有百利而无一害,甚至可以使快新闻渐渐慢下来,也给与读者思索与品读的时间。

面对巨大数据量处理时降低出错量

对于经济、体育类的新闻,常常有许多数字.数据须要整理汇总。人类记者在处理这种数字、图表时,常常由于数据量大而忙中出错.但是,机器人凭着其强悍的运算能力,可以处理海量数据,且不容易出错。

不带有个人情感.文章更加客观

机器人新闻小带有任何人类情感,文章的生成完全依赖于数据。比如在比赛汇总上,不会由于喜爱某支球员而厚此薄彼。而是严格依照数据,客观地陈述事实。在某种程度上,机器人新闻更接近新闻上对客观性的要求。

媒体对“新闻机器人”的报导

三、目前机器人写稿存在的问题

机器人对信息的深度理解不够

新闻机器人所能做的只是在现有数据库的支持下,对文章进行词汇和句子的抓取,然后进行排列组合,就像在进行一个复杂的填字游戏那样。机器人对文章的深度理解能力还远远不能与人类相提并论。虽然身为第二代新闻机器人,在语义理解上仍具有很大缺陷。但随着机器学习能力的不断提升.相信这些低级错误是完全可以避免的。

扁平化新闻千篇一律,缺乏亮点和重点

对信息的提炼和概括能力不足

要想把一篇文章写好,对信息的概括和提炼能力是一个记者必备的职业素质,长而空洞的文章是没有人看的。但目前的写作机器人其实没有提炼和概括的能力,提炼与概括的前提是理解,机器人对于人类语言的理解能力还非常弱,这就限制了机器人写作的文章体裁和领域。

写作领域较为单一,目前局限为财经和体育

机器人新闻当前的应用还逗留在以使用数据为主的新闻领域。具体的说是在财经和体育方面。主要工作是年度财报新闻以及比赛新闻。而且大部分的新闻机器人都较为单一的从事某一领域的写作。很少能“身兼数职”、“一机多能”。这一方面是因为其初始写作模块的设置,功能较为单一,未能考虑到深读学习功能:另一方面.数据壁垒的造成其不能获取学习更多的数据资料,导致其”知之很少”.

四、未来机器人新闻的未来发展方向

跨领域的多面手

目前来看.新闻机器人的写作能力还仅仅逗留在某一领域。一方面,现有的机器人写手不象人类一样.可以眼观六路耳听八方,它的处理器能力还挺单.。交叉数据的处理能力太弱。其次,数据库的开源也是阻碍新闻机器人跨领域上作的一个障碍.机器人写手只有接入到相应的数据库中能够继续进行剖析数据,加工模板.再套用写作。不同数据库之间的开源以及数据的整合促使机器人的跨领域写作有一定阻力。因此,像新华网的快笔小新.它似乎是有3个分身,每个分身各处理一个领域的新闻消息。但是,机器人的发展不可能局限于某一领域。随着其数据处理能力的提高,以及数据开源成为可能.跨领域的机器人新闻写作将成为可能,这样一来,不仅大大节省了成本,而且写出的稿件将愈发全面,不同数据库的资料可以互相补充.取长补短。写作的类型也将不仅仅局限于短消息。使得人物通信.甚至时政评论成为可能。

人类记者、編辑的助手

将来的新闻编辑部太可能出现二加一的局面,即机器人记者同人类记者撰稿,机器人编辑同编辑共同初审把关。机器人记者可以对大量文本,音视频数据进行处理,形成报导提纲或数据图表,经过一轮对数据的加工,使得记者省去了查阅资料,整理汇总的不便,对报导重心做到心小有数.下笔有神。同时,可以协助编辑校对文稿.并快速发布到各媒体终端。

平等的交流者

目前为止.写作机器人还逗留在单向度的接受指令,进行运算的层面。也就是说机器人还只能逗留在辅助记者工作的阶段。但相信在不久的将来,随着数据量的增多,机器的运算能力的降低.以及机器对于自然语言理解能力的提高,机器人可以平等地同人类进行交流,对人类的意见进行反馈建议。

多平台终端、数据库资源的连通者

未来随着各机构数据库、不问平台之间的不断开源,新闻机器人可以实现“推”与“拉’’ 的多平台终端,数据库资源连通。一方面可以将写好的稿件快速同时上传到多个媒体平台,例如近日机器人小明可以将所写明日头条的稿件白动共享到微博平台:另一方面,将不同数据库连通上去:使得数据交叉整合,发挥更大的效能。

媒介融合的推动者

新闻机器人小明在此次亚运新闻报导中加入了图象辨识,可以选购出合适的赛事画面作为文章配图。在今后的发展中机器人甚至可以将视频、音频甚至虚拟现实技术整合上去。实现真正地媒介融合。新闻机器人和可能是今后媒介融合的一个具体产物,它出现在新闻现场,根据新闻对象须要,安装相应的新闻模块,装配虚拟现实摄像头,可以快速写稿、现场直播,制作VR作品.未来的新闻机器人发展的可能性是无限的。

小传点题

个性化新闻推送对新闻生产机制、受众的塑造与发展策略

一、对新闻生产机制的塑造

新闻生产的智能化数据驱动范式:数据引擎成为内容“标配”:瀲活“长尾内容”,满足用户的小众化需求

新闻内容分发成为专业化的独立部门.:集社交、搜索,场景辨识,个性化推送、智能化聚合于一体

二、对受众的塑造

个性化新闻推送之利:有助于“使用与满足”范式下用户地位的升级

个性化新闻推送之弊:易引起用户信息消费的固化和“信息茧房”效应的形成

三、个性化新闻推送机制未来的发展进路与技术重点

走出“茧房”效应:基于用户的社交数据和相关关系“定义”潜在需求

“聊新闻”:基于人工智能的人机交互模式可以对个性化精准信息服务起到扩张和挖掘作用

连接物联网:用户获取的不单单是简单的新闻资讯:而是一整套相关的配套服务,信息获取平台也弄成一个实现精准服务的超内容社区

【课程类型 】 全程班

【时间】2018年4月至12月

四月至暑期前期以新闻学传播学为主,基本囊括了823和440的全部考点,更偏向基础知识的考察,帮助你们筑牢基础,更好的应对二期的拔高。进入假期开始全科学习,针对简答、论述题题训练,总结热点风波,把握华工考察方向,帮助提升分数,提高应试能力,系统讲解答题方法和答题方法。十一月开始系统模拟,考场全仿真,让你出场不慌,考场有底。

每次讲解完后会按照课程进行当堂检查,帮助你们更好理解新学知识。

课下作业可以引导你们的备考方向和练习角度。

不定期进行模拟考帮助了解对知识的把握程度和个人排行。

小班制,答疑

赠送纸质备考资料、课程资料、模拟试题,赠送价值199的模拟试卷答疑班

预报考或订购补习资料的朋友专享价:999三月一日后恢复原价1099

长按关注下方二维码,提前步入华工新传加油站!

发帖助手 智能发贴软件 排行大全

采集交流 • 优采云 发表了文章 • 0 个评论 • 197 次浏览 • 2020-08-27 12:51

nbsp; 软件可以实现任何小型B2B网站发布信息包括门户博客、大型峰会、文章投递、分类信息、贴吧问吧、WIKI百科、相册、新卫论,各种中小博客、分类信息、公司网站、问答平台、自问自答、、注册帐号、加网站好友、加粉丝、抢沙发、重新编辑、替换内容、批量刷新、、删除等功能、文章采集、伪原创处理、自动加联接、文章串联、友情链接、签名档设置等功能,但那些有个缺点就是开那个网站的账和只能发那一个网站不能想发那个平台就发那个平台囊括了所有的发布领域。

nbsp; 甚至他还可以模拟取代手工玩网页、看小说、微信网页好友信息发布。一句话概括只要这个平台您能用键盘点击,能用鼠标输入,那么我们的软件就可以实现不过她们的用上去很简单,并且弄好后在笔记本上就不用管了等发完了在去换个产品就。

nbsp;nbsp;nbsp;nbsp;

软件特色

1、nbsp; 一键生成上万标题一键生成上万条不重复标题,任意设置标题格式,只要你能想到,一键采集关键字快速完成...

2、nbsp; 本地文档手动优化一键指定本地文档目录,自动优化每位文档内容,并随机与用户设置内容手动合并随机搭配组合生成原创内容...

3、nbsp; 外链图片一键批量采集可直接打开网址一键采集网站上所有图片,可以直接批量到本地,可直接随机插入内容中调用!

nbsp;nbsp;nbsp;nbsp;

4、nbsp; 自定义属性参数标签可完全按照产品须要自由添加删节产品参数属性,也可自由设挚产品简略介绍,直接供软件快速调用...

5、nbsp; 完全模拟手工发布可视化发布过程,每一个点击,每一个输入都可以直接看见,真实的模拟了用户的按键键盘输入,保证了帐号安全...

nbsp;nbsp;nbsp;nbsp;

6、nbsp; 验证码手动云端打码软件内提供了多手动打码功能,90以上准确率,另外提供了手工输入,自动辨识简单验证码等功能...

7、nbsp; 强大的违禁词过滤可随便指定多个违禁词手动过滤或手动替换、关键字、近义词、词组随便过滤替换,大大提升发布成功率...

8、nbsp; 强大的网站管理可分组管理网站,每个网站可以无限添加管理会员帐号,可无限添加动作分组,无缝衔接,清楚明了...

nbsp; 只要您自动能实现的功能,随意发软件都可以实现。他可益意设置完全可根据您的看法思路实现想要的模拟操作不过她们的用上去很简单,并且弄好后在笔记本上就不用管了等发完了在去换个产品就好了。软件可达10人以上专业SEO团队效率,发布权重高精品内容,排名高,仅次于直接推广,节省大量人力物力,以及推广费用不过她们的用上去很简单,并且弄好后在笔记本上就不用管了等发完了在去。软件发布大量首页,为您直接带来大量订单,业绩不断翻番!

nbsp; 软件提供了众多自定义变量,随意添加各类段落随机组合,以及手动生成新的段落,为整篇精品内容强有力的打下基础但这种有个缺点就是开那个网站的账和只能发那一个网站不能想发那个平台就发那个平台。软件可任意指定本地图片,可对图片,批量大小,尺寸,批量添加文字图片水印,也可直接批量采集外链图片,批量保存本地,也可直接调阅外链地址!

nbsp; 用户可自由启用提供违禁词列表,以及个人随便添加所须要的违禁词,可手动过滤,替换,截取等等不过她们的用上去很简单,并且弄好后在笔记本上就不用管了等发完了在去换个产品就。信息内容,可以由用户自由指定本地目录文档调用,自动插入各类变量,同时可在内容中随机插入标签、随意组合语句、内容图片、外链图片,内容字符过滤替换,只要您能想到,基本就可以实现,软件终可输出每条完全不同的精品内容不过她们的用上去很简单,并且弄好后在笔记本上就不用管了等发完了在去换个产品就但这种有。 查看全部

发帖助手 智能发贴软件 排行大全

nbsp; 软件可以实现任何小型B2B网站发布信息包括门户博客、大型峰会、文章投递、分类信息、贴吧问吧、WIKI百科、相册、新卫论,各种中小博客、分类信息、公司网站、问答平台、自问自答、、注册帐号、加网站好友、加粉丝、抢沙发、重新编辑、替换内容、批量刷新、、删除等功能、文章采集、伪原创处理、自动加联接、文章串联、友情链接、签名档设置等功能,但那些有个缺点就是开那个网站的账和只能发那一个网站不能想发那个平台就发那个平台囊括了所有的发布领域。

nbsp; 甚至他还可以模拟取代手工玩网页、看小说、微信网页好友信息发布。一句话概括只要这个平台您能用键盘点击,能用鼠标输入,那么我们的软件就可以实现不过她们的用上去很简单,并且弄好后在笔记本上就不用管了等发完了在去换个产品就。

nbsp;nbsp;nbsp;nbsp;

软件特色

1、nbsp; 一键生成上万标题一键生成上万条不重复标题,任意设置标题格式,只要你能想到,一键采集关键字快速完成...

2、nbsp; 本地文档手动优化一键指定本地文档目录,自动优化每位文档内容,并随机与用户设置内容手动合并随机搭配组合生成原创内容...

3、nbsp; 外链图片一键批量采集可直接打开网址一键采集网站上所有图片,可以直接批量到本地,可直接随机插入内容中调用!

nbsp;nbsp;nbsp;nbsp;

4、nbsp; 自定义属性参数标签可完全按照产品须要自由添加删节产品参数属性,也可自由设挚产品简略介绍,直接供软件快速调用...

5、nbsp; 完全模拟手工发布可视化发布过程,每一个点击,每一个输入都可以直接看见,真实的模拟了用户的按键键盘输入,保证了帐号安全...

nbsp;nbsp;nbsp;nbsp;

6、nbsp; 验证码手动云端打码软件内提供了多手动打码功能,90以上准确率,另外提供了手工输入,自动辨识简单验证码等功能...

7、nbsp; 强大的违禁词过滤可随便指定多个违禁词手动过滤或手动替换、关键字、近义词、词组随便过滤替换,大大提升发布成功率...

8、nbsp; 强大的网站管理可分组管理网站,每个网站可以无限添加管理会员帐号,可无限添加动作分组,无缝衔接,清楚明了...

nbsp; 只要您自动能实现的功能,随意发软件都可以实现。他可益意设置完全可根据您的看法思路实现想要的模拟操作不过她们的用上去很简单,并且弄好后在笔记本上就不用管了等发完了在去换个产品就好了。软件可达10人以上专业SEO团队效率,发布权重高精品内容,排名高,仅次于直接推广,节省大量人力物力,以及推广费用不过她们的用上去很简单,并且弄好后在笔记本上就不用管了等发完了在去。软件发布大量首页,为您直接带来大量订单,业绩不断翻番!

nbsp; 软件提供了众多自定义变量,随意添加各类段落随机组合,以及手动生成新的段落,为整篇精品内容强有力的打下基础但这种有个缺点就是开那个网站的账和只能发那一个网站不能想发那个平台就发那个平台。软件可任意指定本地图片,可对图片,批量大小,尺寸,批量添加文字图片水印,也可直接批量采集外链图片,批量保存本地,也可直接调阅外链地址!

nbsp; 用户可自由启用提供违禁词列表,以及个人随便添加所须要的违禁词,可手动过滤,替换,截取等等不过她们的用上去很简单,并且弄好后在笔记本上就不用管了等发完了在去换个产品就。信息内容,可以由用户自由指定本地目录文档调用,自动插入各类变量,同时可在内容中随机插入标签、随意组合语句、内容图片、外链图片,内容字符过滤替换,只要您能想到,基本就可以实现,软件终可输出每条完全不同的精品内容不过她们的用上去很简单,并且弄好后在笔记本上就不用管了等发完了在去换个产品就但这种有。

知产资讯|| 世界知识产权组织推出先进人工智能商标图形检索工具

采集交流 • 优采云 发表了文章 • 0 个评论 • 177 次浏览 • 2020-08-27 09:28

2019年4月1日,世界知识产权组织官网发布了“产权组织推出先进人工智能商标图形检索工具”新闻,文章显示推出新的人工智能驱动图形检索技术,有助于更快更轻松地确认商标在目标市场的辨识力。往代的图形检索工具主要通过辨识商标中的形状和颜色来确认商标图形的近似性。

世界知识产权组织的新一代人工智能技术改进了这项技术,利用深度机器学习来辨识图形中的概念组合——例如苹果、鹰、树、王冠、汽车、星星等,以发觉注册过的近似商标。

这项新技术使潜在近似商标的查找结果更窄、更精确。由于要考量的结果更少,所以节省了商标审查员、律师和律师助理、业内人士和研究人员的劳动成本。

“在商标领域,我们先进的人工智能技术是一项重要改进,让人们在设计新的图形商标时更有掌握,监视潜在的误导性或冲突注册也愈加便捷,”产权组织总干事高锐说。“在全球化经济中,寻求品牌保护的经济主体数目在迅速扩大,这种提高的商业情报非常宝贵。”

世界知识产权组织新的人工智能检索技术借助了深度神经网络和来自商标国际注册马德里体系及几大商标局的图形要素分类数据。

这项人工智能检索技术早已完全整合进产权组织的全球品牌数据库搜索引擎,所有用户都可免费访问。

检索覆盖面

新的检索功能覆盖了早已出席项目的45个商标局的国家数据(包括没有使用图形要素分类系统的局)。到目前为止,这代表了总计3,800万个商标。产权组织常常往数据库中降低世界各地的新数据。

“全世界对知识产权的需求不断下降,让当前一代的系统不堪重负,这正是产权组织领导开发人工智能工具,以建立全球知识产权体系的缘由,”高锐说。“数据池越大,人工智能的结果就越好,所以我鼓励这些数据还没有步入全球品牌数据库的商标局考虑尽早加入。”

人工智能图形近似算法使用户可以将其与任何其他检索标准联合上去使用,例如把检索结果清单限制到个别管辖县,或者限制到尼斯分类的一个或多个类。尼斯分类是一种商标注册用商品和服务国际分类法。

提交复杂或组合图形的用户,可以使用内建的编辑工具裁剪图形中须要的检索县,进一步简化待检图形,使检索结果相关性更强。

举 例

以下标志人工智能驱动的概念查询和形状查询对比:

人工智能驱动的概念策略算法发觉图形中的概念,返回的优先结果包括:

非人工智能的形状策略算法着重于标志的整体形状,返回的优先结果包括:

世界知识产权组织人工智能背景

世界知识产权组织不断探求新技术,确保全球知识产权体系有最高的效率和质量。一支新的人工智能研制团队早已开发了数种新工具,包括人工智能驱动的商标检索功能和专利文本神经机器翻译工具WIPO Translate。

1月,世界知识产权组织发布了新的“技术趋势”研究丛书的第一部。这份报告对专利申请和科学出版物中的专利数据进行剖析,从中发觉行业最新趋势。报告对人工智能创新做了划分和评判,发现了自上世纪50年代人工智能首次出现以来发表的34万多项人工智能相关专利和160万篇科学论文。所有人工智能相关专利申请中,多数是在2013年以后公布的。

地址:曲水县才纳乡尼达路99号

电话:0891-6861622

邮箱: 查看全部

知产资讯|| 世界知识产权组织推出先进人工智能商标图形检索工具

https://mmbiz.qpic.cn/mmbiz_gi ... %3Dgif" />

https://mmbiz.qpic.cn/mmbiz_gi ... %3Dgif" />2019年4月1日,世界知识产权组织官网发布了“产权组织推出先进人工智能商标图形检索工具”新闻,文章显示推出新的人工智能驱动图形检索技术,有助于更快更轻松地确认商标在目标市场的辨识力。往代的图形检索工具主要通过辨识商标中的形状和颜色来确认商标图形的近似性。

世界知识产权组织的新一代人工智能技术改进了这项技术,利用深度机器学习来辨识图形中的概念组合——例如苹果、鹰、树、王冠、汽车、星星等,以发觉注册过的近似商标。

这项新技术使潜在近似商标的查找结果更窄、更精确。由于要考量的结果更少,所以节省了商标审查员、律师和律师助理、业内人士和研究人员的劳动成本。

“在商标领域,我们先进的人工智能技术是一项重要改进,让人们在设计新的图形商标时更有掌握,监视潜在的误导性或冲突注册也愈加便捷,”产权组织总干事高锐说。“在全球化经济中,寻求品牌保护的经济主体数目在迅速扩大,这种提高的商业情报非常宝贵。”

世界知识产权组织新的人工智能检索技术借助了深度神经网络和来自商标国际注册马德里体系及几大商标局的图形要素分类数据。

这项人工智能检索技术早已完全整合进产权组织的全球品牌数据库搜索引擎,所有用户都可免费访问。

检索覆盖面

新的检索功能覆盖了早已出席项目的45个商标局的国家数据(包括没有使用图形要素分类系统的局)。到目前为止,这代表了总计3,800万个商标。产权组织常常往数据库中降低世界各地的新数据。

“全世界对知识产权的需求不断下降,让当前一代的系统不堪重负,这正是产权组织领导开发人工智能工具,以建立全球知识产权体系的缘由,”高锐说。“数据池越大,人工智能的结果就越好,所以我鼓励这些数据还没有步入全球品牌数据库的商标局考虑尽早加入。”

人工智能图形近似算法使用户可以将其与任何其他检索标准联合上去使用,例如把检索结果清单限制到个别管辖县,或者限制到尼斯分类的一个或多个类。尼斯分类是一种商标注册用商品和服务国际分类法。

提交复杂或组合图形的用户,可以使用内建的编辑工具裁剪图形中须要的检索县,进一步简化待检图形,使检索结果相关性更强。

举 例

以下标志人工智能驱动的概念查询和形状查询对比:

https://mmbiz.qpic.cn/mmbiz_jp ... 3Djpeg" />

https://mmbiz.qpic.cn/mmbiz_jp ... 3Djpeg" />人工智能驱动的概念策略算法发觉图形中的概念,返回的优先结果包括:

https://mmbiz.qpic.cn/mmbiz_jp ... 3Djpeg" />

https://mmbiz.qpic.cn/mmbiz_jp ... 3Djpeg" />非人工智能的形状策略算法着重于标志的整体形状,返回的优先结果包括:

https://mmbiz.qpic.cn/mmbiz_jp ... 3Djpeg" />

https://mmbiz.qpic.cn/mmbiz_jp ... 3Djpeg" />世界知识产权组织人工智能背景

世界知识产权组织不断探求新技术,确保全球知识产权体系有最高的效率和质量。一支新的人工智能研制团队早已开发了数种新工具,包括人工智能驱动的商标检索功能和专利文本神经机器翻译工具WIPO Translate。

1月,世界知识产权组织发布了新的“技术趋势”研究丛书的第一部。这份报告对专利申请和科学出版物中的专利数据进行剖析,从中发觉行业最新趋势。报告对人工智能创新做了划分和评判,发现了自上世纪50年代人工智能首次出现以来发表的34万多项人工智能相关专利和160万篇科学论文。所有人工智能相关专利申请中,多数是在2013年以后公布的。

https://mmbiz.qpic.cn/mmbiz_jp ... 3Djpeg" />

https://mmbiz.qpic.cn/mmbiz_jp ... 3Djpeg" />地址:曲水县才纳乡尼达路99号

电话:0891-6861622

邮箱:

网站内容更新有绝技

采集交流 • 优采云 发表了文章 • 0 个评论 • 366 次浏览 • 2020-08-26 00:42

的文章原创度高达90%,可读性高达100% ,此方式也是seowhy网站站长夫唯 老师主推的方式。

请看:夫唯老师关于“获取文章的方式”视频教程

工作流程:采集文章——内容相关的多篇文章进行组合——发布到网站。

系统的价值:令人激动的地方在于整个过程无需人工参与,是一套标准的无人值守、智能采集、智能组合、自动上传的伪原创系统。

下面请看演示视频:

演示视频分为2个部份:

1、优采云2010免费版采集数据和防去重生成器演示

2、防去重生成器全自动版演示

演示视频一 :以9分20秒为分隔,前面是优采云2010免费版采集数据,后面是防去重生成器演示

相关文章和防去重生成器的获取请移步到:

演示视频二 :防去重生成器全自动版演示

相关文章和防去重生成器全自动版获取 请移步到:

下面是图文说明

1 、首先设置好采集参数,整个设置过程只须要 5 分钟 。

2、开启优采云进行数据的采集和发布,并且将优采云设置为手动运行(免费版本会提示没有手动功能,无需理会此提示,确定即可),如果订购了优采云的商业版本,会拥有愈发强悍的功能

3 、到目标网站去看发布疗效,如图所示:

整个过程的在无人值守的情况下完成,

只要系统开着,数据都会源源不断的发布到网站

查看全部

网站内容更新有绝技

的文章原创度高达90%,可读性高达100% ,此方式也是seowhy网站站长夫唯 老师主推的方式。

请看:夫唯老师关于“获取文章的方式”视频教程

工作流程:采集文章——内容相关的多篇文章进行组合——发布到网站。

系统的价值:令人激动的地方在于整个过程无需人工参与,是一套标准的无人值守、智能采集、智能组合、自动上传的伪原创系统。

下面请看演示视频:

演示视频分为2个部份:

1、优采云2010免费版采集数据和防去重生成器演示

2、防去重生成器全自动版演示

演示视频一 :以9分20秒为分隔,前面是优采云2010免费版采集数据,后面是防去重生成器演示

相关文章和防去重生成器的获取请移步到:

演示视频二 :防去重生成器全自动版演示

相关文章和防去重生成器全自动版获取 请移步到:

下面是图文说明

1 、首先设置好采集参数,整个设置过程只须要 5 分钟 。

2、开启优采云进行数据的采集和发布,并且将优采云设置为手动运行(免费版本会提示没有手动功能,无需理会此提示,确定即可),如果订购了优采云的商业版本,会拥有愈发强悍的功能

3 、到目标网站去看发布疗效,如图所示:

整个过程的在无人值守的情况下完成,

只要系统开着,数据都会源源不断的发布到网站

2018最佳人工智能数据采集(爬虫)工具书下载

采集交流 • 优采云 发表了文章 • 0 个评论 • 380 次浏览 • 2020-08-25 20:04

Python网路数据采集

图片.png

图片.png

Python网路数据采集 - 2016.pdf

本书采用简约强悍的Python语言,介绍了网路数据采集,并为采集新式网路中的各类数据类型提供了全面的指导。第 1部份重点介绍网路数据采集的基本原理:如何用Python从网路服务器恳求信息,如何对服务器的响应进行基本处理,以及怎样以自动化手段与网站进行交互。第 二部份介绍怎样用网络爬虫测试网站,自动化处理,以及怎样通过更多的形式接入网路。

Web Scraping with Python 2nd - 2018.pdf

2000左右星

精通Python爬虫框架Scrapy

图片.png

Scrapy是使用Python开发的一个快速、高层次的屏幕抓取和Web抓取框架,用于抓Web站点并从页面中提取结构化的数据。《精通Python爬虫框架Scrapy》以Scrapy 1.0版本为基础,讲解了Scrapy的基础知识,以及怎样使用Python和三方API提取、整理数据,以满足自己的需求。

本书共11章,其内容涵括了Scrapy基础知识,理解HTML和XPath,安装Scrapy并爬取一个网站,使用爬虫填充数据库并输出到联通应用中,爬虫的强悍功能,将爬虫布署到Scrapinghub云服务器,Scrapy的配置与管理,Scrapy编程,管道绝招,理解Scrapy性能,使用Scrapyd与实时剖析进行分布式爬取。本书附表还提供了各类软件的安装与故障排除等内容。

本书适宜软件开发人员、数据科学家,以及对自然语言处理和机器学习感兴趣的人阅读。

Learning Scrapy -2016.pdf 另有英文电子版本 因为版权早已在CSDN等网站下架,可以在qq群144081101等找到。

python3爬虫基础

图片.png

在线教程

200 左右星

First web scraper

教程:

200 左右星

Practical Web Scraping for Data Science -Best Practices and Examples with Python - 2018.pdf

图片.png

星级 低于100

This book provides a complete and modern guide to web scraping, using Python as the programming language, without glossing over important details or best practices. Written with a data science audience in mind, the book explores both scraping and the larger context of web technologies in which it operates, to ensure full understanding. The authors recommend web scraping as a powerful tool for any data scientist’s arsenal, as many data science projects start by obtaining an appropriate data set.

Starting with a brief overview on scraping and real-life use cases, the authors explore the core concepts of HTTP, HTML, and CSS to provide a solid foundation. Along with a quick Python primer, they cover Selenium for JavaScript-heavy sites, and web crawling in detail. The book finishes with a recap of best practices and a 采集 of examples that bring together everything you've learned and illustrate various data science use cases.

用Python写网路爬虫 第2版

图片.png

《用Python写网路爬虫(第 2版》讲解了怎样使用Python来编撰网路爬虫程序,内容包括网路爬虫简介,从页面中抓取数据的3种方式,提取缓存中的数据,使用多个线程和进程进行并发抓取,抓取动态页面中的内容,与表单进行交互,处理页面中的验证码问题,以及使用Scarpy和Portia进行数据抓取,并在最后介绍了使用本书讲解的数据抓取技术对几个真实的网站进行抓取的实例,旨在帮助读者活学活用书中介绍的技术。

《用Python写网路爬虫(第 2版》适合有一定Python编程经验并且对爬虫技术感兴趣的读者阅读。

图片.png

Python Web Scraping 2nd Edition - 2017.pdf

第一版英文 用Python写网路爬虫.pdf

参考资料

最好用的Python爬虫推荐 查看全部

2018最佳人工智能数据采集(爬虫)工具书下载

Python网路数据采集

图片.png

图片.png

Python网路数据采集 - 2016.pdf

本书采用简约强悍的Python语言,介绍了网路数据采集,并为采集新式网路中的各类数据类型提供了全面的指导。第 1部份重点介绍网路数据采集的基本原理:如何用Python从网路服务器恳求信息,如何对服务器的响应进行基本处理,以及怎样以自动化手段与网站进行交互。第 二部份介绍怎样用网络爬虫测试网站,自动化处理,以及怎样通过更多的形式接入网路。

Web Scraping with Python 2nd - 2018.pdf

2000左右星

精通Python爬虫框架Scrapy

图片.png

Scrapy是使用Python开发的一个快速、高层次的屏幕抓取和Web抓取框架,用于抓Web站点并从页面中提取结构化的数据。《精通Python爬虫框架Scrapy》以Scrapy 1.0版本为基础,讲解了Scrapy的基础知识,以及怎样使用Python和三方API提取、整理数据,以满足自己的需求。

本书共11章,其内容涵括了Scrapy基础知识,理解HTML和XPath,安装Scrapy并爬取一个网站,使用爬虫填充数据库并输出到联通应用中,爬虫的强悍功能,将爬虫布署到Scrapinghub云服务器,Scrapy的配置与管理,Scrapy编程,管道绝招,理解Scrapy性能,使用Scrapyd与实时剖析进行分布式爬取。本书附表还提供了各类软件的安装与故障排除等内容。

本书适宜软件开发人员、数据科学家,以及对自然语言处理和机器学习感兴趣的人阅读。

Learning Scrapy -2016.pdf 另有英文电子版本 因为版权早已在CSDN等网站下架,可以在qq群144081101等找到。

python3爬虫基础

图片.png

在线教程

200 左右星

First web scraper

教程:

200 左右星

Practical Web Scraping for Data Science -Best Practices and Examples with Python - 2018.pdf

图片.png

星级 低于100

This book provides a complete and modern guide to web scraping, using Python as the programming language, without glossing over important details or best practices. Written with a data science audience in mind, the book explores both scraping and the larger context of web technologies in which it operates, to ensure full understanding. The authors recommend web scraping as a powerful tool for any data scientist’s arsenal, as many data science projects start by obtaining an appropriate data set.

Starting with a brief overview on scraping and real-life use cases, the authors explore the core concepts of HTTP, HTML, and CSS to provide a solid foundation. Along with a quick Python primer, they cover Selenium for JavaScript-heavy sites, and web crawling in detail. The book finishes with a recap of best practices and a 采集 of examples that bring together everything you've learned and illustrate various data science use cases.

用Python写网路爬虫 第2版

图片.png

《用Python写网路爬虫(第 2版》讲解了怎样使用Python来编撰网路爬虫程序,内容包括网路爬虫简介,从页面中抓取数据的3种方式,提取缓存中的数据,使用多个线程和进程进行并发抓取,抓取动态页面中的内容,与表单进行交互,处理页面中的验证码问题,以及使用Scarpy和Portia进行数据抓取,并在最后介绍了使用本书讲解的数据抓取技术对几个真实的网站进行抓取的实例,旨在帮助读者活学活用书中介绍的技术。

《用Python写网路爬虫(第 2版》适合有一定Python编程经验并且对爬虫技术感兴趣的读者阅读。

图片.png

Python Web Scraping 2nd Edition - 2017.pdf

第一版英文 用Python写网路爬虫.pdf

参考资料

最好用的Python爬虫推荐

AI文章智能处理软件 v2.0官方版

采集交流 • 优采云 发表了文章 • 0 个评论 • 251 次浏览 • 2020-08-22 21:31

3、百度新闻采集:一键搜索各类行业新闻文章,数据源为百度新闻搜索引擎,资源丰富,操作灵活,不需要编撰任何采集规则,但缺点是搜集的文章不是必须完整,但可以满足大多数用户的需求。友善提示:使用文章时请标明文章出处,并尊重原创版权。

4,行业文章集:一键搜索相关行业网站文章,该网站行业有装潢家饰行业,机械行业,建材行业,家电行业,五金行业,美容行业,育儿行业,金融行业,游戏行业行业,SEO行业,女性保健行业等,该网站有数十个网站,资源丰富,模块可能难以满足所有顾客的需求,但是顾客可以提出要求,我们将改进和更新模块资源。该模块的功能是它不需要编撰获取规则,即一键操作。友善提示:使用文章时请标明文章出处,并尊重原创版权。

5,写收款规则:自己写收款规则,收款规则符合通常的正则表达式,写收款规则须要了解一些html代码和正则表达式规则,如果您早已写过其他店家的收款规则,那么必须编撰我们的软件的搜集规则,我们有提供编撰搜集规则的文档。我们不帮顾客写收款规则,如果须要写的话,10元一条收单规则。友善提示:使用文章时请标明文章出处,并尊重原创版权。

6,外链文章材料:模块是通过大量的行业语料,通过算法随机组合语料库生产相关的行业文章,模块文章仅适合于文章质量要求不高,为外链的促销用户,模块的特点,资源丰富,原创性高,但缺点是文章可读性差,用户在使用时可以有选择地使用它。

7.批量生产标题:有两个功能,一个是通过关键字和规则组合批量生产标题,第二个是通过搜集网路大数据来获取标题。自动生成的促销准确性很高,并且捕获的标题可读,每种都有优点和缺点。

8,文章界面发布:通过简单的配置,将生成的文章一键发布到自己的网站上。当前受支持的站点是Discuz Portal,DedeCms,帝国 ECMS(新闻),PHMCMS,齐博 CMS,PHP168,diypage,phpwind门户。

9,SEO批量查询工具:权重批量查询,排名批量查询,收录批量查询,长尾词挖掘,代码批量转换,文本加揭秘。 查看全部

AI文章智能处理软件 v2.0官方版

3、百度新闻采集:一键搜索各类行业新闻文章,数据源为百度新闻搜索引擎,资源丰富,操作灵活,不需要编撰任何采集规则,但缺点是搜集的文章不是必须完整,但可以满足大多数用户的需求。友善提示:使用文章时请标明文章出处,并尊重原创版权。

4,行业文章集:一键搜索相关行业网站文章,该网站行业有装潢家饰行业,机械行业,建材行业,家电行业,五金行业,美容行业,育儿行业,金融行业,游戏行业行业,SEO行业,女性保健行业等,该网站有数十个网站,资源丰富,模块可能难以满足所有顾客的需求,但是顾客可以提出要求,我们将改进和更新模块资源。该模块的功能是它不需要编撰获取规则,即一键操作。友善提示:使用文章时请标明文章出处,并尊重原创版权。

5,写收款规则:自己写收款规则,收款规则符合通常的正则表达式,写收款规则须要了解一些html代码和正则表达式规则,如果您早已写过其他店家的收款规则,那么必须编撰我们的软件的搜集规则,我们有提供编撰搜集规则的文档。我们不帮顾客写收款规则,如果须要写的话,10元一条收单规则。友善提示:使用文章时请标明文章出处,并尊重原创版权。

6,外链文章材料:模块是通过大量的行业语料,通过算法随机组合语料库生产相关的行业文章,模块文章仅适合于文章质量要求不高,为外链的促销用户,模块的特点,资源丰富,原创性高,但缺点是文章可读性差,用户在使用时可以有选择地使用它。

7.批量生产标题:有两个功能,一个是通过关键字和规则组合批量生产标题,第二个是通过搜集网路大数据来获取标题。自动生成的促销准确性很高,并且捕获的标题可读,每种都有优点和缺点。

8,文章界面发布:通过简单的配置,将生成的文章一键发布到自己的网站上。当前受支持的站点是Discuz Portal,DedeCms,帝国 ECMS(新闻),PHMCMS,齐博 CMS,PHP168,diypage,phpwind门户。

9,SEO批量查询工具:权重批量查询,排名批量查询,收录批量查询,长尾词挖掘,代码批量转换,文本加揭秘。

阿里云 大数据教你玩转娱乐圈

采集交流 • 优采云 发表了文章 • 0 个评论 • 183 次浏览 • 2020-08-22 20:05

” 不仅这般,公众趋势剖析原先还是阿里小ai的一只“眼睛”,帮助小ai成功预测了《我是歌手》决赛的粉丝投票排名。今天名厨带你一起用他闯一闯娱乐圈。

必备产品:

单价:UI大众版 69元/年 8月2日 10:00准时发售!

阿里云公众趋势剖析的应用场景则包括政府机关、传媒机构、金融行业、地产行业、教育行业、医疗行业、旅游行业、企业品牌等。

一、注册与订购

此前它以每个月1元(UI体验版)的体验价钱(现在升级为UI大众版69元/元)向公众开放,大厨就以这个价钱任性地尝试了一把——首先打开阿里云·数加的官方链接,然后点击该网页右侧的“立即订购”,就能进行注册、缴费与使用了。

二、使用流程——以近日吴亦凡风波为例

注册并开通“公众趋势剖析”服务以后,便能进行配置测量专题、关键词和参数并剖析采集内容变化趋势了。

(一) 设置监控的专题和关键词

首次步入“公众趋势剖析”管理控制台,需要为剖析对象配置监控专题和关键词, 可以用监控专题的一个或多个关键词组合进行描述。

数加官网“快速开始”称:

“系统后台将采集收录那些关键词组合的文章内容,进行汇总剖析。后续一些统计功能将主要针对监控专题进行操作,所以尽量为每位剖析对象创建一个单独的监控专题。”

八卦的主厨为此次热热闹闹的吴亦凡风波专门开辟了一个专题并设置了关键词组合—首先点击后台管理的关键字,继而点击添加专题,然后进行关键词配置。

大厨一口气添加了吴亦凡、小G娜、卓伟、加拿大炮王等一系列热点词汇,选择了包括新闻、论坛、微博、微信在内的所有给定源站,生成的专题如下:

据官方说明,关键词配置的要点如下:

“配置关键词时主要考虑以下两方面诱因。(注意:系统后台每10分钟就会更新全局的关键词采集策略,因此新的关键词递交配置以后,需要10分钟左右生效。)

○ 采集范围:需要在什么类型的站点上采集内容。源站类型可以包括:新闻、论坛、贴吧、微博、微信、政府网站和视频类网站。

○ 组合方法:关键词怎样组合,是否添加同义、近义、通假或网上用语的变体,这可能须要花一些时间逐渐调整。另外,请不要设置过分笼统的关键词组合,例如“网络”、“安全”等单个词,这会采集过多不相关的文章,导致您的采集数量配额快速用尽。如下图所示,一次可批量添加多个关键词组合,每一行表示一个关键词组合。根据您购买的版本不同,关键词组合的数目(即行数)有不同的上限。一个关键词组合可以由单个或则多个词组成,词与词之间用空格分隔,表示“与”的关系:必须同时 收录一行中所有词的信息就会被采集。”

(二) 查看采集内容

这下才能开始关注舆情动态了,点击两侧导航栏的“新舆情”或者“全部舆情就”可以查看关键词采集到的文章列表。列表中标题字体加粗的表示未读文章,点击某一条文章将在右边显示文章的详尽信息。

大厨随机点开其中一篇文本,如下图,情感早已被手动设定为“负面”,而标签、情感(正面、中性、负面)、风险等级、备注等信息都可以进行自定义,同时,大厨将这篇信息设置为有效。

值得注意的是,标记训练是机器学习的过程,据官方说明:

标记训练“可自动勾选文章标题,批量标记为‘有效’、‘无效’或‘已读’。‘有效’表示这种文章是值得重点关注的,‘无效’表示这种文章属于干扰信息。手动标记的过程,实际上是在训练后台的智能分类模型,一般经过100篇左右的标记训练然后,系统的分类模型将越来越确切,结合‘过滤规则’可以实现智能过滤, 后续采集到不相关的内容(如广告、干扰信息、垃圾信息),即可手动划入‘回收站’。”

同时,该应用还提供了文章的搜索功能,点击文章上面的搜索按键,便可以从多维度筛选文章。

(三) 查看结果剖析报表

最后点击两侧导航栏的“首页”,便可以查看相关剖析报表,可以查看“今天”、“7天”、“30天”的剖析结果。

三、结果展示

大厨检查了从6月21日到6月24日关于此风波的结果。

源站类型和热词云分析如下图所示,结果显示:微博成为这次风波的主要舆论场,符合你们的潜在认知。

然而,关于采集到的舆情数目,大厨心有疑问。在微博搜索“吴亦凡”的发文数目远远超过“公众趋势剖析”在微博四天内共搜集到的2万多条。这说明该应用的数据筛选有着自己的一套标准,且该标准获取的样本量显著偏小,“大数据”的搜集能力还需后续观察。

结果显示:

对于此次吴亦凡负面风波的公众情感剖析,6.21-6.24日的均值为1,公众的正面情绪稍为抢占上风,说明大量粉丝甚至是脑残粉持续进行舆论攻势。

6.23日公众的正面情绪有较高的上升,这与吴亦凡名誉侵权案结案具有一致性。

以6.24日为例,全天的对此风波的想法相对中性,但在清晨四点到10点达到情感高峰,说明双方的立场僵持以支持者抢占上风(反对者可能都在睡梦中)。

一言以蔽之,大厨对该应用之于发文的手动情感判定相当服气,虽然有一些文章存在疏漏之处,但大部分都能确切定性。

分析结果显示6.21-6.24日?——热门风波TOP10为:

通过上述图表可知,吴亦凡此番风波的后续发酵和迈向与一些热点风波和炒作有关——吴亦凡名誉侵权案高踞热门风波前二,6.22日早晨的结案推动舆情数目迈向高峰。这说明了吴亦凡方的公关做法在实质的迈向中起到了影响和率领粉丝进行舆情反攻的作用。

四、 功能点评

优点:

1.情感剖析较为出众,能够较为确切地表现舆情迈向。

2.自动化操作和检查,界面简约,使用简单。

缺点:

1.目前应用平台不太成熟,存在一些bug。

a) 删除设定的专题后,专题内的关键词并不会在舆情的界面消失,还是会继续在云端加载数据,且无法删除。

b) 首页的剖析结果并非依照某一单一专题得出,而是所有关键词的汇总剖析结果,且难以设定,这一点十分不合理。例如你有两个不同须要检查的专题“京东618”和“吴亦凡”,首页的情感剖析、词云统计太有可能是所有测量文本的集合结果,目前难以实现对不同专题的差异化结果显示。因此,该平台目前对具有单一的测量主题的受众较为适用。

2.抓取的数据量不够完整,且舆情数目很容易达到上限。(大厨仅仅检查了4天吴亦凡风波,控制台的上便捷有如下提示。)

3.若干更为实用的工具还未向公众开放。如下图,开放插口下的传播路径剖析等功能还未开放,因此数据的使用和剖析具有局限性。

PS:大厨发觉,前几日的1元体验版现在已渐次下架,取而代之的是69元/年的大众版,据负责人透漏:1元钱的体验版为上个月的活动价,对数据量进行了控制,每天仅能抓取1万条信息,功能较弱;而今的69元/年的大众版,每天可以抓取30万条信息,大大提高了该平台的剖析容量,算是真正商业化了。这确也部份解答了主厨的体验困扰。当然,大厨只是体验了初级版,各位boys或则girls,值得拥有大众版!

公众趋势剖析地址: 查看全部

阿里云 大数据教你玩转娱乐圈

” 不仅这般,公众趋势剖析原先还是阿里小ai的一只“眼睛”,帮助小ai成功预测了《我是歌手》决赛的粉丝投票排名。今天名厨带你一起用他闯一闯娱乐圈。

必备产品:

单价:UI大众版 69元/年 8月2日 10:00准时发售!

阿里云公众趋势剖析的应用场景则包括政府机关、传媒机构、金融行业、地产行业、教育行业、医疗行业、旅游行业、企业品牌等。

一、注册与订购

此前它以每个月1元(UI体验版)的体验价钱(现在升级为UI大众版69元/元)向公众开放,大厨就以这个价钱任性地尝试了一把——首先打开阿里云·数加的官方链接,然后点击该网页右侧的“立即订购”,就能进行注册、缴费与使用了。

二、使用流程——以近日吴亦凡风波为例

注册并开通“公众趋势剖析”服务以后,便能进行配置测量专题、关键词和参数并剖析采集内容变化趋势了。

(一) 设置监控的专题和关键词

首次步入“公众趋势剖析”管理控制台,需要为剖析对象配置监控专题和关键词, 可以用监控专题的一个或多个关键词组合进行描述。

数加官网“快速开始”称:

“系统后台将采集收录那些关键词组合的文章内容,进行汇总剖析。后续一些统计功能将主要针对监控专题进行操作,所以尽量为每位剖析对象创建一个单独的监控专题。”

八卦的主厨为此次热热闹闹的吴亦凡风波专门开辟了一个专题并设置了关键词组合—首先点击后台管理的关键字,继而点击添加专题,然后进行关键词配置。

大厨一口气添加了吴亦凡、小G娜、卓伟、加拿大炮王等一系列热点词汇,选择了包括新闻、论坛、微博、微信在内的所有给定源站,生成的专题如下:

据官方说明,关键词配置的要点如下:

“配置关键词时主要考虑以下两方面诱因。(注意:系统后台每10分钟就会更新全局的关键词采集策略,因此新的关键词递交配置以后,需要10分钟左右生效。)

○ 采集范围:需要在什么类型的站点上采集内容。源站类型可以包括:新闻、论坛、贴吧、微博、微信、政府网站和视频类网站。

○ 组合方法:关键词怎样组合,是否添加同义、近义、通假或网上用语的变体,这可能须要花一些时间逐渐调整。另外,请不要设置过分笼统的关键词组合,例如“网络”、“安全”等单个词,这会采集过多不相关的文章,导致您的采集数量配额快速用尽。如下图所示,一次可批量添加多个关键词组合,每一行表示一个关键词组合。根据您购买的版本不同,关键词组合的数目(即行数)有不同的上限。一个关键词组合可以由单个或则多个词组成,词与词之间用空格分隔,表示“与”的关系:必须同时 收录一行中所有词的信息就会被采集。”

(二) 查看采集内容

这下才能开始关注舆情动态了,点击两侧导航栏的“新舆情”或者“全部舆情就”可以查看关键词采集到的文章列表。列表中标题字体加粗的表示未读文章,点击某一条文章将在右边显示文章的详尽信息。

大厨随机点开其中一篇文本,如下图,情感早已被手动设定为“负面”,而标签、情感(正面、中性、负面)、风险等级、备注等信息都可以进行自定义,同时,大厨将这篇信息设置为有效。

值得注意的是,标记训练是机器学习的过程,据官方说明:

标记训练“可自动勾选文章标题,批量标记为‘有效’、‘无效’或‘已读’。‘有效’表示这种文章是值得重点关注的,‘无效’表示这种文章属于干扰信息。手动标记的过程,实际上是在训练后台的智能分类模型,一般经过100篇左右的标记训练然后,系统的分类模型将越来越确切,结合‘过滤规则’可以实现智能过滤, 后续采集到不相关的内容(如广告、干扰信息、垃圾信息),即可手动划入‘回收站’。”

同时,该应用还提供了文章的搜索功能,点击文章上面的搜索按键,便可以从多维度筛选文章。

(三) 查看结果剖析报表

最后点击两侧导航栏的“首页”,便可以查看相关剖析报表,可以查看“今天”、“7天”、“30天”的剖析结果。

三、结果展示

大厨检查了从6月21日到6月24日关于此风波的结果。

源站类型和热词云分析如下图所示,结果显示:微博成为这次风波的主要舆论场,符合你们的潜在认知。

然而,关于采集到的舆情数目,大厨心有疑问。在微博搜索“吴亦凡”的发文数目远远超过“公众趋势剖析”在微博四天内共搜集到的2万多条。这说明该应用的数据筛选有着自己的一套标准,且该标准获取的样本量显著偏小,“大数据”的搜集能力还需后续观察。

结果显示:

对于此次吴亦凡负面风波的公众情感剖析,6.21-6.24日的均值为1,公众的正面情绪稍为抢占上风,说明大量粉丝甚至是脑残粉持续进行舆论攻势。

6.23日公众的正面情绪有较高的上升,这与吴亦凡名誉侵权案结案具有一致性。

以6.24日为例,全天的对此风波的想法相对中性,但在清晨四点到10点达到情感高峰,说明双方的立场僵持以支持者抢占上风(反对者可能都在睡梦中)。

一言以蔽之,大厨对该应用之于发文的手动情感判定相当服气,虽然有一些文章存在疏漏之处,但大部分都能确切定性。

分析结果显示6.21-6.24日?——热门风波TOP10为:

通过上述图表可知,吴亦凡此番风波的后续发酵和迈向与一些热点风波和炒作有关——吴亦凡名誉侵权案高踞热门风波前二,6.22日早晨的结案推动舆情数目迈向高峰。这说明了吴亦凡方的公关做法在实质的迈向中起到了影响和率领粉丝进行舆情反攻的作用。

四、 功能点评

优点:

1.情感剖析较为出众,能够较为确切地表现舆情迈向。

2.自动化操作和检查,界面简约,使用简单。

缺点:

1.目前应用平台不太成熟,存在一些bug。

a) 删除设定的专题后,专题内的关键词并不会在舆情的界面消失,还是会继续在云端加载数据,且无法删除。

b) 首页的剖析结果并非依照某一单一专题得出,而是所有关键词的汇总剖析结果,且难以设定,这一点十分不合理。例如你有两个不同须要检查的专题“京东618”和“吴亦凡”,首页的情感剖析、词云统计太有可能是所有测量文本的集合结果,目前难以实现对不同专题的差异化结果显示。因此,该平台目前对具有单一的测量主题的受众较为适用。

2.抓取的数据量不够完整,且舆情数目很容易达到上限。(大厨仅仅检查了4天吴亦凡风波,控制台的上便捷有如下提示。)

3.若干更为实用的工具还未向公众开放。如下图,开放插口下的传播路径剖析等功能还未开放,因此数据的使用和剖析具有局限性。

PS:大厨发觉,前几日的1元体验版现在已渐次下架,取而代之的是69元/年的大众版,据负责人透漏:1元钱的体验版为上个月的活动价,对数据量进行了控制,每天仅能抓取1万条信息,功能较弱;而今的69元/年的大众版,每天可以抓取30万条信息,大大提高了该平台的剖析容量,算是真正商业化了。这确也部份解答了主厨的体验困扰。当然,大厨只是体验了初级版,各位boys或则girls,值得拥有大众版!

公众趋势剖析地址:

智能采集组合文章标题起好了,后期怎么去优化

采集交流 • 优采云 发表了文章 • 0 个评论 • 285 次浏览 • 2021-03-21 20:04

智能采集组合文章采集比如新浪采集然后就自动生成标题,标签。设置好关键词,连接等,用热度,排名,搜索量高的关键词,按照搜索页数,调整生成相对应的页面标题,标签。然后保存下来,

真正的做大新浪新闻采集,没有什么捷径,基本上,标题起好了,标签起好了,文章标题起好了,后期怎么去优化,

利用百度搜索引擎原创能力强大,不定期用账号来各大门户网站或者是自媒体网站发布新闻更换标题原文编辑同步即可现在互联网追求原创热点新闻,新闻热点可以大家看看今日头条,

最主要的还是写好标题,一般写的标题越短越好,可以加一个副标题。一个标题就是一个连接。

引导文章进入公众号直接发送关键词即可

百度已经不错了,再往下做就乏力了,其实多关注一些专业行业的网站,看看那些牛逼的比如云计算,可以大批量抓取。抓取后生成伪原创,然后优化。

如果新浪微博,论坛,贴吧等都没有帐号,或者帐号名字中带有一个新闻的字样,

根据目标用户人群进行关键词分析,记录好你觉得可以写出标题的词,先熟悉关键词的分布,可以整理成为excel表格,用access保存好,避免漏网之鱼。接下来是优化文章的标题,然后抓取相关关键词作为伪原创,从而做到文章的精细化,可以尝试垂直媒体,多盟写作平台,认证自媒体等,通过不断地修改文章,提高文章质量,提高原创度。推荐,我是艾市姿,从事新媒体营销12年,希望我的回答能够帮助到你。 查看全部

智能采集组合文章标题起好了,后期怎么去优化

智能采集组合文章采集比如新浪采集然后就自动生成标题,标签。设置好关键词,连接等,用热度,排名,搜索量高的关键词,按照搜索页数,调整生成相对应的页面标题,标签。然后保存下来,

真正的做大新浪新闻采集,没有什么捷径,基本上,标题起好了,标签起好了,文章标题起好了,后期怎么去优化,

利用百度搜索引擎原创能力强大,不定期用账号来各大门户网站或者是自媒体网站发布新闻更换标题原文编辑同步即可现在互联网追求原创热点新闻,新闻热点可以大家看看今日头条,

最主要的还是写好标题,一般写的标题越短越好,可以加一个副标题。一个标题就是一个连接。

引导文章进入公众号直接发送关键词即可

百度已经不错了,再往下做就乏力了,其实多关注一些专业行业的网站,看看那些牛逼的比如云计算,可以大批量抓取。抓取后生成伪原创,然后优化。

如果新浪微博,论坛,贴吧等都没有帐号,或者帐号名字中带有一个新闻的字样,

根据目标用户人群进行关键词分析,记录好你觉得可以写出标题的词,先熟悉关键词的分布,可以整理成为excel表格,用access保存好,避免漏网之鱼。接下来是优化文章的标题,然后抓取相关关键词作为伪原创,从而做到文章的精细化,可以尝试垂直媒体,多盟写作平台,认证自媒体等,通过不断地修改文章,提高文章质量,提高原创度。推荐,我是艾市姿,从事新媒体营销12年,希望我的回答能够帮助到你。

一款很不错的文章处理工具,可以进行素材采集

采集交流 • 优采云 发表了文章 • 0 个评论 • 282 次浏览 • 2021-03-20 22:05

AI 文章智能处理软件是一种智能的文章 伪原创工具,可以帮助用户重组文章以形成新的文章,并且还可以执行物料采集。一个非常好的文章处理工具。

功能介绍:

1、 Intelligent 伪原创:在人工智能中使用自然语言处理技术来实现文章 伪原创处理。核心功能包括“智能伪原创”,“同义词替换伪原创”,“反义词替换伪原创”,“使用html代码在文章中随机插入关键词”,“句子改组和重组”等等等,处理后的文章 原创度和收录比率均高于80%。想了解更多功能,请下载软件进行试用。

2、门户文章 采集:一键式搜索集合相关门户网站新闻文章,网站搜狐,腾讯,新浪,网易,头条。 com,,联合早报,光明网,网站管理员网,新文化网等,用户可以进入行业关键词搜索所需的行业文章。该模块的功能是无需编写采集规则和一键操作。温馨提示:使用文章时,请注明文章的出处并尊重原创文本的版权。

3、百度新闻采集:一键搜索各行各业的新闻文章,数据源来自百度新闻搜索引擎,资源丰富,操作灵活,无需编写任何文件[ 采集规则,但缺点是采集的文章不一定完整,但可以满足大多数用户的需求。温馨提示:使用文章时,请注明文章的出处并尊重原创文本的版权。

4、行业文章 采集:一键式搜索相关产业网站 文章,网站产业包括装饰和家居业,机械业,建材业,家电业,五金业,美容业,育儿业,金融业,游戏业,SEO业,妇女保健业等网站,资源丰富,此模块可能无法满足所有客户的需求,但是客户可以提出自己的需求,我们将改进和更新模块资源。该模块的功能是无需编写采集规则和一键操作。温馨提示:使用文章时,请注明文章的出处并尊重原创文本的版权。

5、编写规则采集:自己编写采集规则采集,采集规则符合常见的正则表达式,编写采集规则需要html代码和正则表达式规则,如果您已经编写了其他公司采集软件的采集规则,您肯定会编写我们软件的采集规则,并且我们提供了编写采集规则的文档。我们不为客户编写采集规则。如果您需要代写它们,则每条采集规则将获得10元。温馨提示:使用文章时,请注明文章的出处并尊重原创文本的版权。

6、外部链接文章资料:该模块使用大量行业语料库,通过算法将语料库随机组合以产生相关行业文章。此模块文章仅适用于质量要求不高的文章。对于通过外部链接升级的用户,此模块的特点是资源丰富且原创的程度很高,但是缺点是文章的可读性很差,用户可以在使用时选择使用它。

7、标题的批量生产:有两个功能,一个是通过关键词和规则的组合来批量生产标题,第二个功能是通过采集网络大数据获取标题。自动生成的促销具有较高的准确性,采集的标题可读,并且各有其优缺点。

8、 文章界面发布:通过简单的配置,只需单击一下,即可将生成的文章发布到您自己的网站中。目前支持的网站是Discuz门户,Dede cms,Empire E cms(新闻),PHM cms,Qibo cms,PHP168,diypage,phpwind门户。

9、 SEO批量查询工具:权重批量查询,排名批量查询,收录批量查询,长尾单词挖掘,编码批量转换,文本加密和解密。 查看全部

一款很不错的文章处理工具,可以进行素材采集

AI 文章智能处理软件是一种智能的文章 伪原创工具,可以帮助用户重组文章以形成新的文章,并且还可以执行物料采集。一个非常好的文章处理工具。

功能介绍:

1、 Intelligent 伪原创:在人工智能中使用自然语言处理技术来实现文章 伪原创处理。核心功能包括“智能伪原创”,“同义词替换伪原创”,“反义词替换伪原创”,“使用html代码在文章中随机插入关键词”,“句子改组和重组”等等等,处理后的文章 原创度和收录比率均高于80%。想了解更多功能,请下载软件进行试用。

2、门户文章 采集:一键式搜索集合相关门户网站新闻文章,网站搜狐,腾讯,新浪,网易,头条。 com,,联合早报,光明网,网站管理员网,新文化网等,用户可以进入行业关键词搜索所需的行业文章。该模块的功能是无需编写采集规则和一键操作。温馨提示:使用文章时,请注明文章的出处并尊重原创文本的版权。

3、百度新闻采集:一键搜索各行各业的新闻文章,数据源来自百度新闻搜索引擎,资源丰富,操作灵活,无需编写任何文件[ 采集规则,但缺点是采集的文章不一定完整,但可以满足大多数用户的需求。温馨提示:使用文章时,请注明文章的出处并尊重原创文本的版权。

4、行业文章 采集:一键式搜索相关产业网站 文章,网站产业包括装饰和家居业,机械业,建材业,家电业,五金业,美容业,育儿业,金融业,游戏业,SEO业,妇女保健业等网站,资源丰富,此模块可能无法满足所有客户的需求,但是客户可以提出自己的需求,我们将改进和更新模块资源。该模块的功能是无需编写采集规则和一键操作。温馨提示:使用文章时,请注明文章的出处并尊重原创文本的版权。

5、编写规则采集:自己编写采集规则采集,采集规则符合常见的正则表达式,编写采集规则需要html代码和正则表达式规则,如果您已经编写了其他公司采集软件的采集规则,您肯定会编写我们软件的采集规则,并且我们提供了编写采集规则的文档。我们不为客户编写采集规则。如果您需要代写它们,则每条采集规则将获得10元。温馨提示:使用文章时,请注明文章的出处并尊重原创文本的版权。

6、外部链接文章资料:该模块使用大量行业语料库,通过算法将语料库随机组合以产生相关行业文章。此模块文章仅适用于质量要求不高的文章。对于通过外部链接升级的用户,此模块的特点是资源丰富且原创的程度很高,但是缺点是文章的可读性很差,用户可以在使用时选择使用它。

7、标题的批量生产:有两个功能,一个是通过关键词和规则的组合来批量生产标题,第二个功能是通过采集网络大数据获取标题。自动生成的促销具有较高的准确性,采集的标题可读,并且各有其优缺点。

8、 文章界面发布:通过简单的配置,只需单击一下,即可将生成的文章发布到您自己的网站中。目前支持的网站是Discuz门户,Dede cms,Empire E cms(新闻),PHM cms,Qibo cms,PHP168,diypage,phpwind门户。

9、 SEO批量查询工具:权重批量查询,排名批量查询,收录批量查询,长尾单词挖掘,编码批量转换,文本加密和解密。

软件介绍软件支持采集好的文章伪原创处理百度收录

采集交流 • 优采云 发表了文章 • 0 个评论 • 279 次浏览 • 2021-01-22 11:33

AI Smart文章采集工具是专门为网站网站管理员创建的文章采集工具。有了它,您可以采集任何网站 文章,采集该方法非常简单,可以帮助网站站长节省大量时间。

软件简介

该软件支持采集,良好的文章伪原创处理。百度收录非常强大,支持保存本地txt,并支持保存优采云数据库文件以进行一键式发布。如果您有自媒体和软文个使用此软件的朋友,他们可以从他人编写的更好的内容中学习!您还可以将标题内容从采集修改为文章,并将其发布为软文,以提高营销效率。

软件功能

1、Intelligent 伪原创:在人工智能中使用自然语言处理技术来实现文章伪原创处理。核心功能包括“智能伪原创”,“同义词替换伪原创”,“反义词替换伪原创”,“使用html代码在文章中随机插入关键词”,“句子改组和重组”等等等,加工后的文章原创度和收录率均高于80%。想了解更多功能,请下载软件进行试用。

2、门户文章采集:一键式搜索集合相关门户网站新闻文章,网站搜狐,腾讯,新浪,网易,头条。 com,,联合早报,光明网,网站管理员网,新文化网等,用户可以进入行业关键词搜索所需的行业文章。该模块的功能是无需编写采集规则和一键操作。温馨提示:使用文章时,请注明文章的出处并尊重原创文本的版权。

3、百度新闻采集:一键搜索各行各业的新闻文章,数据源来自百度新闻搜索引擎,资源丰富,操作灵活,无需编写任何内容[ 采集规则,但缺点是采集的文章不一定完整,但可以满足大多数用户的需求。温馨提示:使用文章时,请注明文章的出处并尊重原创文本的版权。

软件亮点

1、一键采集

新闻搜索采集,百度文章采集,整个网站的一键采集,白家好文章采集,门户网站新闻采集,微信文章采集,列表文章采集,风云列表采集,排名列表文章采集,问答材料采集,列表介绍采集,书写规则采集名称文章等。

2、 文章组合

材料智能组合,段落的随机组合,句子的随机组合,核心内容组合,材料排列和组合,批次文章组合,文本批次划分,段落成对组合,整个文本组合。

3、图片下载

通过关键词自动搜索图片,自动下载,自动删除成批图片中的水印,并在上传图片时自动获取远程网址

更新日志

修复已知错误 查看全部

软件介绍软件支持采集好的文章伪原创处理百度收录

AI Smart文章采集工具是专门为网站网站管理员创建的文章采集工具。有了它,您可以采集任何网站 文章,采集该方法非常简单,可以帮助网站站长节省大量时间。

软件简介

该软件支持采集,良好的文章伪原创处理。百度收录非常强大,支持保存本地txt,并支持保存优采云数据库文件以进行一键式发布。如果您有自媒体和软文个使用此软件的朋友,他们可以从他人编写的更好的内容中学习!您还可以将标题内容从采集修改为文章,并将其发布为软文,以提高营销效率。

软件功能