文章采集完

技巧:微信读书,里面有个神奇的看书提醒,点开以后阅读时间线就会倒转过来

采集交流 • 优采云 发表了文章 • 0 个评论 • 300 次浏览 • 2022-10-02 19:07

文章采集完毕,找个好看的图片作为背景图片,全新办公模式即刻体验,立即下载、快速上手,全新办公模式,给你新的办公新体验。

微信读书,里面有个神奇的看书提醒,点开以后阅读时间线就会倒转过来,提醒你到了开书的时间。手机上应该没有这种软件了,手动在网上找的:在外面闲逛时,某时段看到一本书,点开提醒,读书时间流回去。

微信读书

的确没有,能去豆瓣看看书评,不过评论也不一定看。

我发现有个叫【书旗小说】的app。这个应该是一个阅读器吧,记得里面好像可以看电子书。然后记得在豆瓣或者pp读书上搜索相关介绍。另外推荐一个万能的国内网站,可以看,看电子书,都可以吧。最最重要的是,免费!不要脸的放上去自己的公众号,定期也会推荐一些好书。id:读书吗?三国水浒三个的都有,欢迎大家加入我们的网站(二维码自动识别)。

没有也没有找到不说了该刷剑三了

推荐《清华管理评论》,收录了国内外很多优秀的管理者与管理学者。

本人用的海外上的《合作的革命》这本书,里面有全新的旧视角,从乔布斯时代以来到移动互联网的创新创业者,从组织管理的角度来看待组织对人力资源带来的改变。 查看全部

技巧:微信读书,里面有个神奇的看书提醒,点开以后阅读时间线就会倒转过来

文章采集完毕,找个好看的图片作为背景图片,全新办公模式即刻体验,立即下载、快速上手,全新办公模式,给你新的办公新体验。

微信读书,里面有个神奇的看书提醒,点开以后阅读时间线就会倒转过来,提醒你到了开书的时间。手机上应该没有这种软件了,手动在网上找的:在外面闲逛时,某时段看到一本书,点开提醒,读书时间流回去。

微信读书

的确没有,能去豆瓣看看书评,不过评论也不一定看。

我发现有个叫【书旗小说】的app。这个应该是一个阅读器吧,记得里面好像可以看电子书。然后记得在豆瓣或者pp读书上搜索相关介绍。另外推荐一个万能的国内网站,可以看,看电子书,都可以吧。最最重要的是,免费!不要脸的放上去自己的公众号,定期也会推荐一些好书。id:读书吗?三国水浒三个的都有,欢迎大家加入我们的网站(二维码自动识别)。

没有也没有找到不说了该刷剑三了

推荐《清华管理评论》,收录了国内外很多优秀的管理者与管理学者。

本人用的海外上的《合作的革命》这本书,里面有全新的旧视角,从乔布斯时代以来到移动互联网的创新创业者,从组织管理的角度来看待组织对人力资源带来的改变。

解决方案:人工智能建模时效性的核心的问题需要解决!!

采集交流 • 优采云 发表了文章 • 0 个评论 • 50 次浏览 • 2022-09-30 05:13

文章采集完成后,常用的是批量采集,并且只采集想要的数据。人工智能对采集速度的要求是非常高的,采集批量的数据不一定能很好的满足设备或者系统的响应,从而导致实际数据量并不是很大。还有采集成本大,再就是时效性的问题。人工智能采集还有一些核心的问题需要解决。

用人工智能做是可以的,例如云采集,像是solr或者shimo这种存储性质的。电商数据必须要采集一个数据库,然后通过后台数据的展示进行抓取,目前来说云采集是最好的采集方式。另外需要额外提供些收费保障,例如对于采集网站的限制,例如账号等级或者时效性要求。当然,

你既然要分析这个问题,说明你已经有了人工智能建模的入门知识了。人工智能建模肯定需要一个数据库来支撑。这是一个辅助和补充知识的存在。我们平时需要抓取某商品详情页面的数据,我们抓取的方式是,每抓取一个网页中的某一个商品,然后通过推荐一个相似商品来过滤掉不想要的商品。这种情况下,我们只需要一个商品名,因为有重复,也可以抓取成功。

那么这种情况下数据库中的商品信息,就是一个词汇表,你抓取这个词汇表中的某个商品,然后我们对这个商品进行再次推荐。对于你的问题,我觉得你也不必再自己建立数据库了,找到分析的数据,写个脚本把他爬下来,也可以得到对于想要找到的信息的截图。数据质量你也可以控制。这样每个网页都可以覆盖了。 查看全部

解决方案:人工智能建模时效性的核心的问题需要解决!!

文章采集完成后,常用的是批量采集,并且只采集想要的数据。人工智能对采集速度的要求是非常高的,采集批量的数据不一定能很好的满足设备或者系统的响应,从而导致实际数据量并不是很大。还有采集成本大,再就是时效性的问题。人工智能采集还有一些核心的问题需要解决。

用人工智能做是可以的,例如云采集,像是solr或者shimo这种存储性质的。电商数据必须要采集一个数据库,然后通过后台数据的展示进行抓取,目前来说云采集是最好的采集方式。另外需要额外提供些收费保障,例如对于采集网站的限制,例如账号等级或者时效性要求。当然,

你既然要分析这个问题,说明你已经有了人工智能建模的入门知识了。人工智能建模肯定需要一个数据库来支撑。这是一个辅助和补充知识的存在。我们平时需要抓取某商品详情页面的数据,我们抓取的方式是,每抓取一个网页中的某一个商品,然后通过推荐一个相似商品来过滤掉不想要的商品。这种情况下,我们只需要一个商品名,因为有重复,也可以抓取成功。

那么这种情况下数据库中的商品信息,就是一个词汇表,你抓取这个词汇表中的某个商品,然后我们对这个商品进行再次推荐。对于你的问题,我觉得你也不必再自己建立数据库了,找到分析的数据,写个脚本把他爬下来,也可以得到对于想要找到的信息的截图。数据质量你也可以控制。这样每个网页都可以覆盖了。

事实:文章采集完成,如何防止标准商品再下单生成中间商

采集交流 • 优采云 发表了文章 • 0 个评论 • 109 次浏览 • 2022-09-27 20:07

文章采集完成,本文的展示结构采集是采集淘宝,京东,拼多多的商品信息,为了对后期对标准商品进行再下单生成中间商,未标准商品采集过程中怎么防止标准商品再下单标准商品下单后再次下单,我们通过easybot系统,

新建任务,执行即可。很容易实现,找个脚本语言,或者自己写一个。(脚本语言tail.js使用起来更简单,unity写,

我也在学,搜索,

要说防的话,不太了解标准商品是怎么防的,因为淘宝京东这样的电商模式基本都会建立相应的商品池(例如淘宝的二手平台、京东的原装正品购)。这些商品池也都是各平台下的优质商品,很难遇到有人直接做盗版。对于一些防伪情况一般就是对收货地址做标记、上传发票、数据包扫描核对密码了。标准商品下单生成中间商,第二天再下订单。

最简单的办法,用户下单了,商家如果卖商品,就可以做中间商,去下单,

我没学过怎么做,因为不涉及行业,全凭搜索。比如百度信息流以及自己用的百家号。一是根据搜索记录,哪些账号在搜索,哪些店家销售商品,哪些东西会被买。二是根据账号属性,像我就设定自己的账号用了哪几个品牌哪几个地区下单。

知乎上得到的解决方案无非是账号和产品库做区分。我觉得根本解决问题的方法是, 查看全部

事实:文章采集完成,如何防止标准商品再下单生成中间商

文章采集完成,本文的展示结构采集是采集淘宝,京东,拼多多的商品信息,为了对后期对标准商品进行再下单生成中间商,未标准商品采集过程中怎么防止标准商品再下单标准商品下单后再次下单,我们通过easybot系统,

新建任务,执行即可。很容易实现,找个脚本语言,或者自己写一个。(脚本语言tail.js使用起来更简单,unity写,

我也在学,搜索,

要说防的话,不太了解标准商品是怎么防的,因为淘宝京东这样的电商模式基本都会建立相应的商品池(例如淘宝的二手平台、京东的原装正品购)。这些商品池也都是各平台下的优质商品,很难遇到有人直接做盗版。对于一些防伪情况一般就是对收货地址做标记、上传发票、数据包扫描核对密码了。标准商品下单生成中间商,第二天再下订单。

最简单的办法,用户下单了,商家如果卖商品,就可以做中间商,去下单,

我没学过怎么做,因为不涉及行业,全凭搜索。比如百度信息流以及自己用的百家号。一是根据搜索记录,哪些账号在搜索,哪些店家销售商品,哪些东西会被买。二是根据账号属性,像我就设定自己的账号用了哪几个品牌哪几个地区下单。

知乎上得到的解决方案无非是账号和产品库做区分。我觉得根本解决问题的方法是,

解决方案:如何使用chrome浏览器在chrome中检查网站是否正常?

采集交流 • 优采云 发表了文章 • 0 个评论 • 113 次浏览 • 2022-09-27 14:12

文章采集完成后,进行网站爬虫训练,有了训练数据就可以采集更多的数据了。爬虫训练除了采集网站上的数据外,还可以用来做其他事情。在网站爬虫训练过程中,我们先做网站浏览,这是相对比较简单的。如果你没有查看网站,你将不会有一个新的网站爬虫学习笔记,所以你需要网站浏览。我们可以安装chrome浏览器。然后登录,进入spider。

学习的基本步骤1.下载chrome浏览器,建议在谷歌商店下载。2.在浏览器中,用左键点击f12进入开发者工具,输入以下代码netscape::safari3.检查网站是否正常,js,css中文。(参考“如何使用chrome浏览器在chrome中检查网站是否正常”一文)4.如果网站正常则点击下载,如果未正常,则点击右下角新建脚本的f12进入网站爬虫编辑。

5.复制代码,粘贴到:编辑器,创建名为png的脚本。6.右击新建脚本,如果使用shouzixie的代码,那么只需在common.py后面跟上两个pages,即可给爬虫创建许多页面。如果使用xiew查看common.py,有几个默认的部分:jsessionid:爬虫器的身份号urlheader:爬虫器的头部referred:url,link|textpageicon:爬虫器的图标链接webdev:请求抓取时网站的dom信息link_matrix:链接的映射矩阵soup_class:网页标签autopage:是否开启爬虫skip_crawl:是否在爬取时移除抓取的网页p.s.在common.py后面添加page_crawl参数表示在下载过程中断开。

7.在其中添加页码处理操作的代码即可。8.下载完成后,你可以看到爬虫器在你指定的页面中进行抓取并返回了composite_image。9.点击编辑器右上角的“f12”进入代码管理。10.点击f12后会弹出鼠标样式,我们在这里进行一些样式设置即可。代码图示及最终效果-content.png11.修改爬虫器的头部,使用js加载url,设置代理来获取正则表达式。

12.在common.py代码尾部添加抓取代理,修改正则匹配。13.在spider.py代码尾部增加模拟键盘修改监听。在知识星球将原来的爬虫器的代码上传,并进行分享。 查看全部

解决方案:如何使用chrome浏览器在chrome中检查网站是否正常?

文章采集完成后,进行网站爬虫训练,有了训练数据就可以采集更多的数据了。爬虫训练除了采集网站上的数据外,还可以用来做其他事情。在网站爬虫训练过程中,我们先做网站浏览,这是相对比较简单的。如果你没有查看网站,你将不会有一个新的网站爬虫学习笔记,所以你需要网站浏览。我们可以安装chrome浏览器。然后登录,进入spider。

学习的基本步骤1.下载chrome浏览器,建议在谷歌商店下载。2.在浏览器中,用左键点击f12进入开发者工具,输入以下代码netscape::safari3.检查网站是否正常,js,css中文。(参考“如何使用chrome浏览器在chrome中检查网站是否正常”一文)4.如果网站正常则点击下载,如果未正常,则点击右下角新建脚本的f12进入网站爬虫编辑。

5.复制代码,粘贴到:编辑器,创建名为png的脚本。6.右击新建脚本,如果使用shouzixie的代码,那么只需在common.py后面跟上两个pages,即可给爬虫创建许多页面。如果使用xiew查看common.py,有几个默认的部分:jsessionid:爬虫器的身份号urlheader:爬虫器的头部referred:url,link|textpageicon:爬虫器的图标链接webdev:请求抓取时网站的dom信息link_matrix:链接的映射矩阵soup_class:网页标签autopage:是否开启爬虫skip_crawl:是否在爬取时移除抓取的网页p.s.在common.py后面添加page_crawl参数表示在下载过程中断开。

7.在其中添加页码处理操作的代码即可。8.下载完成后,你可以看到爬虫器在你指定的页面中进行抓取并返回了composite_image。9.点击编辑器右上角的“f12”进入代码管理。10.点击f12后会弹出鼠标样式,我们在这里进行一些样式设置即可。代码图示及最终效果-content.png11.修改爬虫器的头部,使用js加载url,设置代理来获取正则表达式。

12.在common.py代码尾部添加抓取代理,修改正则匹配。13.在spider.py代码尾部增加模拟键盘修改监听。在知识星球将原来的爬虫器的代码上传,并进行分享。

解读:一个月之内没有被采集的情况就是单篇文章

采集交流 • 优采云 发表了文章 • 0 个评论 • 110 次浏览 • 2022-09-26 09:12

文章采集完成之后,最怕出现的情况就是单篇文章一个月之内没有被采集。我经历过,只想说我也经历过,自己写的文章想让app看,app没有同步,让我经历了分析一整个月,哪怕是每个月单独统计一下app统计情况,可能也要数月之久,才能有一个结果。后来咨询了相关技术人员,他们给了我一个不需要app的解决方案,让我尝试了之后确实有所改观。

这里是收集采集的github链接,如果有需要帮助的也可以私信我:alexzhq/mt-demo,我可以尝试以下操作,后续可能会公布最新实现方法。

1)添加相关github源码:

1).把需要操作的源码下载到本地(mirrors/android/source/cornerstone/public_http_apis/android_web_apis)

2).解压,如果有可能把源码复制下来(解压后有两个文件夹,source文件夹,

2)添加pipeline,github有build。gradle和release的插件用来解决依赖问题,目前文章列表已经是最后的依赖清单了,先下载地址看下,如下:-web。gradle+android_web_apis2。7其中configuration文件,需要注意,android_web_apis,如果你的androidmanifest配置文件没有用\configuration来配置的话,最后会在android_web_apis中显示null,所以在dependency那一项配置上:{"android。

web。app。main。application":"application","android。web。app。main。view":"view","android。web。app。main。field。view_text":"text","android。web。app。main。field。

view_text_result":"result","android。web。app。main。field。view_value":"value","android。web。app。main。field。view_value_attribute":"attribute","android。

web。app。main。field。view_field_section":"field","android。web。app。main。field。view_field_attribute_name":"section","android。web。app。main。field。

field。view_section_name":"field","android。web。app。main。field。view_field_attribute_name":"field","android。web。app。main。field。

view_field_attribute_name":"field","android。web。app。main。field。f。 查看全部

解读:一个月之内没有被采集的情况就是单篇文章

文章采集完成之后,最怕出现的情况就是单篇文章一个月之内没有被采集。我经历过,只想说我也经历过,自己写的文章想让app看,app没有同步,让我经历了分析一整个月,哪怕是每个月单独统计一下app统计情况,可能也要数月之久,才能有一个结果。后来咨询了相关技术人员,他们给了我一个不需要app的解决方案,让我尝试了之后确实有所改观。

这里是收集采集的github链接,如果有需要帮助的也可以私信我:alexzhq/mt-demo,我可以尝试以下操作,后续可能会公布最新实现方法。

1)添加相关github源码:

1).把需要操作的源码下载到本地(mirrors/android/source/cornerstone/public_http_apis/android_web_apis)

2).解压,如果有可能把源码复制下来(解压后有两个文件夹,source文件夹,

2)添加pipeline,github有build。gradle和release的插件用来解决依赖问题,目前文章列表已经是最后的依赖清单了,先下载地址看下,如下:-web。gradle+android_web_apis2。7其中configuration文件,需要注意,android_web_apis,如果你的androidmanifest配置文件没有用\configuration来配置的话,最后会在android_web_apis中显示null,所以在dependency那一项配置上:{"android。

web。app。main。application":"application","android。web。app。main。view":"view","android。web。app。main。field。view_text":"text","android。web。app。main。field。

view_text_result":"result","android。web。app。main。field。view_value":"value","android。web。app。main。field。view_value_attribute":"attribute","android。

web。app。main。field。view_field_section":"field","android。web。app。main。field。view_field_attribute_name":"section","android。web。app。main。field。

field。view_section_name":"field","android。web。app。main。field。view_field_attribute_name":"field","android。web。app。main。field。

view_field_attribute_name":"field","android。web。app。main。field。f。

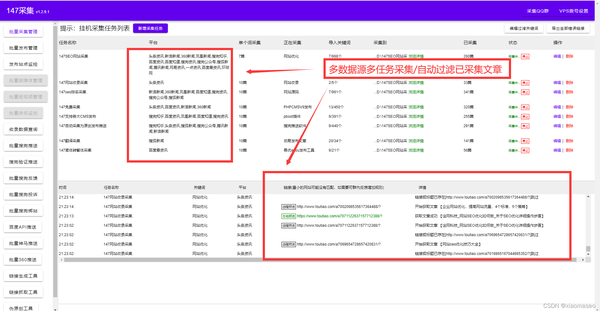

解决方案:网钛cms各种风格模板通用采集伪原创发布工具

采集交流 • 优采云 发表了文章 • 0 个评论 • 199 次浏览 • 2022-09-24 03:15

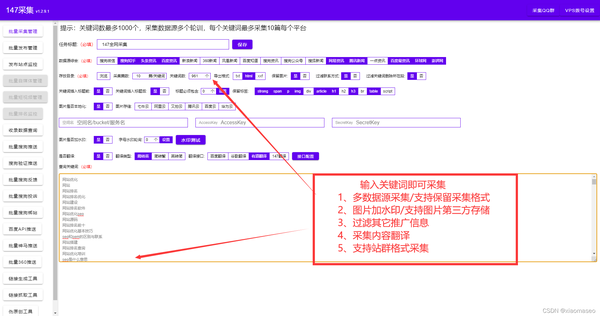

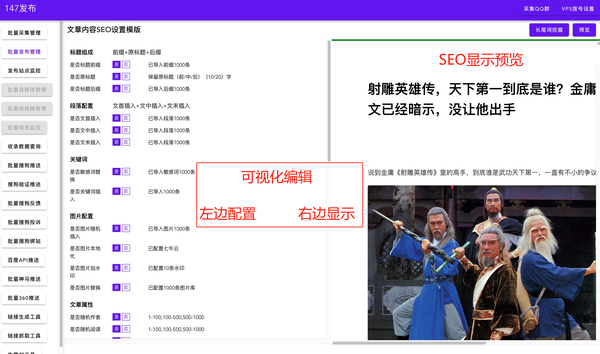

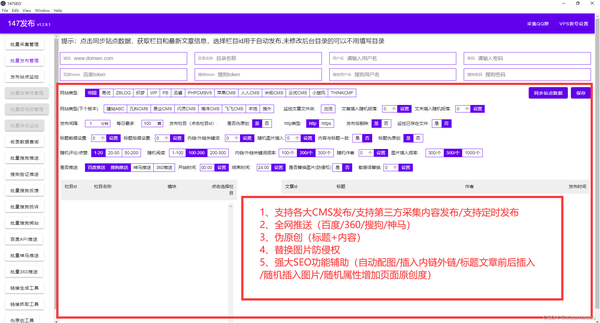

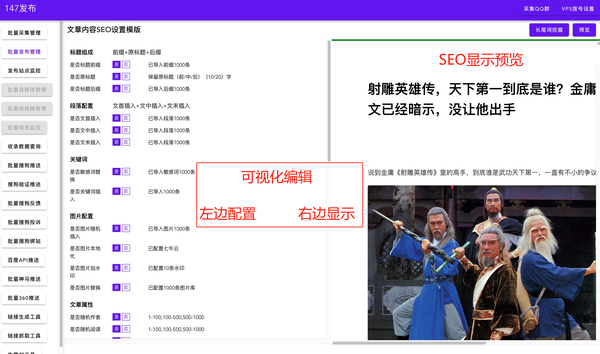

Net Titaniumcms各种样式模板通用采集伪原创发布工具

SEO技术分享2022-03-05

如何优化网帖cms让网站快速收录和关键词排名,seo优化其实是网站优化的一部分,不管是不是网站包括内部优化,或者站外优化,从而提高在搜索引擎上的排名,SEO优化的每一步都可以逐步提升网站的排名。

一、关键词分析

SEO优化的第一步也是本次优化中最重要的一步。就是分析需要注意的关键词的数量,关键词和网站的相关性,关键词的布局和排名预测等等。各部分相互独立,但环环相扣,标题和内容与关键词密切相关,很容易被收录和搜索引擎所接受。

二、网站架构分析

主要包括结构设计中不符合人性化设计的部分剔除,实现简洁明了的目录结构,创意独特的网站导航,突出显眼,优质广泛外部链接等。在这个分析过程中,需要进行市场调研,了解用户的需求和喜好,自行进行相关的优化处理工作网站,不仅有利于网站的结构整理,也有利于SEO优化。

三、网站目录和页面优化

这也是SEO优化的基本操作。优化网站的基本信息,保证用户浏览后对网站有一定的了解和熟悉。需要注意的是,网站的目录要有一定的逻辑性。如果有自己的页数,需要保证目录的每一项都可以在内部链接到每一个字幕;页面字体大小要合适,不能因为太小而失去大量视力不佳的消费者,也不能因为太大、信息量少而失去强迫症或扩散能力弱的用户.

四、内容分发和链接放置

SEO优化的重要步骤之一是内容的定期发布和更新。需要合理安排网站内容的更新时间表及相关信息;而对于网站的内部链接和外部链接,要确保网页的关键词醒目,可以轻松捕捉重要信息。

五、网站更新频率

a网站 更新得越频繁,搜索引擎蜘蛛就会越频繁地出现。因此,我们可以利用网帖cms的免费工具实现采集伪原创的自动发布,主动推送给搜索引擎,提高搜索引擎的抓取频率。本网体cms采集操作简单,无需学习专业技术,简单几步即可轻松采集内容数据,用户只需在网体上进行操作cms@ >采集工具设置简单,工具会根据用户设置的关键词准确采集文章,保证与行业一致< @文章。 采集中的采集文章可以选择将修改后的内容保存到本地,也可以直接选择在软件上发布。

相比Neti的其他免费工具cms,这个工具非常好用,只需输入关键词即可实现采集(Neticms免费工具自带< @关键词采集 函数)。只需设置任务,整个过程会自动挂机!

无论你有成百上千个不同的cms网站都可以实现统一管理。一个人维护数百个 网站文章 更新也不是问题。

最重要的是,网钛这个免费工具cms有很多SEO功能,不仅可以提高网站的收录,还可以增加网站的密度@关键词 提高网站排名。

1、网站主动推送(让搜索引擎更快发现我们的网站)

2、自动匹配图片(文章如果内容中没有图片,会自动配置相关图片) 设置自动下载图片并保存在本地或第三方(这样内容不再有对方的外部链接)。

3、自动内部链接(让搜索引擎更深入地抓取您的链接)

4、在内容或标题前后插入段落或关键词(可选择将标题和标题插入同一关键词)

5、网站内容插入或随机作者、随机阅读等变成“身高原创”。

6、相关性优化(关键词出现在正文中,正文第一段会自动插入到title标题中。当描述相关性低时,当前的采集关键词@会自动添加。>。文本会自动插入当前采集关键词中随机位置两次。当当前采集@的关键词 > 出现在文本中,关键词 会自动加粗。)

7、正规发布(正规发布文章让搜索引擎及时抓取你的网站内容)

使用这些 SEO 功能提高 网站 页面的 收录 排名。通过工具上的监控管理查看文章采集的发布和主动推送(百度/360/搜狗神马/谷歌等),而不是每次登录网站后台天。 SEO的内容优化直接在工具上自动完成。目前博主亲测软件是免费的,可以直接下载使用!

六、网页质量优化

我们一直在强调网站在seo优化中的重要性,在设计网站的时候就已经开始SEO优化了。我们都知道网站 是由无数的网页组成的。在我们最初设计网站的时候,我们肯定有一个网站的主题,而这个主题决定了网站的具体内容和方向。我如何了解 网站 的主题? 网站的主题其实是每个网页的内容都支持的,所以在构建网站的时候一定要注意网页的质量,不管是不是网站首页或者网站网站中的独立页面都会参与排名,可见网页质量的重要性。那么页面质量对SEO优化有什么影响呢?

1、内容质量维度

百度搜索引擎评价网页内容的质量主要根据其主要内容的质量以及主要内容能否满足用户。不同类型网页的主要内容是不同的。百度搜索引擎在判断不同网页的内容价值时,需要注意的点也不同,比如:

首页:导航链接和推荐内容是否清晰有效。

文章页面:能提供清晰完整的内容,最好有图有文字。

产品页面:是否提供完整真实的产品信息和有效的购买入口。

问答页面:它是否提供有用的答案。

下载页面:是否提供下载入口,是否有权限限制,资源是否有效。

文档页面:是否可以被用户阅读,是否有权限限制。

搜索结果页面:搜索结果是否与标题相关。

关键词1@>

关键词2@>

百度搜索引擎从多个维度考虑网页内容的质量,最重要的是:成本;内容完整性;信息真实、有效、安全。我们举个例子看看百度搜索引擎是如何对网页的内容质量进行分类的。请对比自己网站的页面,从搜索引擎和用户的角度给自己打分:

2、浏览体验维度

不同质量的网页带来的浏览体验会有很大差异。优质网页带来的浏览体验应该是积极的。用户希望看到干净且易于阅读的网页。版面混乱、广告过多会影响用户对网页主要内容的访问。在百度搜索引擎网页质量体系中,用户获取网页主要内容的成本与浏览体验成反比,即获取成本越高,浏览体验越低。对于内容质量相近的网页,浏览体验较好的网页更有可能获得较高的排名,而对于浏览体验较差的网页,百度搜索引擎会视情况降低其展示概率甚至拒绝收录 .

影响用户浏览体验的因素有很多。目前百度搜索引擎主要从内容布局和广告影响两个方面考虑网页:

内容布局:用户进入网页时首先看到的是内容布局。布局决定了用户对网页的第一印象,也决定了用户获取内容的成本。

广告影响力:百度搜索引擎明白网站的生存和发展需要资金支持,支持在网页上投放合法广告。网页的主要目的应该是满足用户需求。最好的状态是“主内容和广告一起满足用户的需求,内容为主,广告为辅”,广告不应该是网页的主体。

3、辅助功能维度

百度搜索引擎会从正常打开、权限限制、有效性三个方面来判断网页的可访问性。对于可以正常访问的页面,可以参与正常排序;对于有权限限制的页面,可以通过其他维度进行排名。观察;对于无效网页,展示机制将被降级甚至从数据库中删除。

关键词5@>

看完这篇文章,如果你觉得不错,不妨采集一下,或者发给需要的朋友和同事。关注博主,每天给你展示各种SEO经验,让你的网站快速收录和关键词排名也!

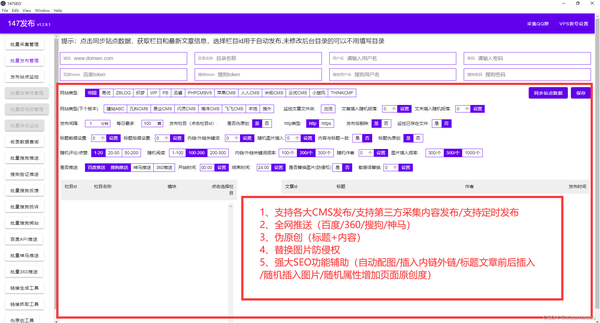

正式推出:UCMS采集发布插件,各类CMS通用的采集发布插件

Ucms作为一个开源系统,我们可以通过采集发布工具来管理我们的网站内容,Ucms采集发布插件完成整个对网站文章进行全网素材采集、批量内容编辑和伪原创发布、一键提交URL到搜索引擎的流程管理。

Ucms的采集功能,通过关键词挖掘长尾关键词以及一键采集全网相关文章热门平台,让我们获取了大量的关键词@文章材料。我们也可以通过视觉指定采集来实现定点网站内容的采集。搜索引擎喜欢具有流行性和及时性的内容。通过Ucms的采集函数,我们可以获取大量的文章素材进行创作。

Ucms 批量编辑我们通过SEO模板采集的素材。模板通过文字、图片、标签等对我们的文字进行处理,我们不仅可以替换我们的文章图片、图片水印处理、标题前缀和后缀、换词等,还可以翻译我们的文字,< @伪原创和tdk提取,实现文章材料的批量处理。

我们可能想浏览结果列表并寻找潜在的关键字,重要的是要知道在优化我们的标题标签时,我们应该寻找我们定位的主要关键字。结果数据有时可能会产生误导,因为位置可以随时跳入或跳出前一百名或介于两者之间的任何位置。我们还可以使用 Ucms采集 发布插件来获得更精确的关键字位置。

我们的 SEO 技巧之一是通过延迟加载提高 网站 的速度。如果我们以前从未听说过延迟加载,我们应该知道它是指在页面加载时延迟加载渲染阻塞资源。简而言之,图像和视频仅在页面上可见时才会加载。通过这样做,我们将减少初始页面加载时间以及页面的初始权重和系统资源使用 - 所有这些都会对我们的 网站 性能产生积极影响。

我们可能已经知道页面速度是一个关键的排名因素,加载速度更快的页面为我们的潜在访问者提供了更好的用户体验。所以我们可以减少某些指标,比如跳出率。内部链接在 SEO 中至关重要。内部链接改善和提高了可抓取性,确保我们的页面被更快地编入索引,并增加主题相关性,以便我们的 网站 在搜索引擎上排名更高。

因此,我们建议我们在 网站 上查找与主题相关的页面,一旦有新帖子发布,我们就可以链接到这些页面。在将它们添加到新页面之前,我们还可以使用正确的 SEO 工具查看每个页面的 URL 评级。作为初学者,我们应该知道 URL 评级,也称为 UR,代表了页面反向链接配置文件的整体强度。

Ucms采集发布插件的分享到此结束。通过使用Ucms采集发布插件,我们不仅可以轻松完成网站管理的内容更新,还可以通过批量管理我们的多个cms插件,从内容编辑、数据采集分析和网站SEO实现对我们一个网站或多个网站的便捷管理,如果你喜欢这个文章 ,你不妨采集并喜欢它。您的支持和鼓励是博主不断更新的动力。 查看全部

解决方案:网钛cms各种风格模板通用采集伪原创发布工具

Net Titaniumcms各种样式模板通用采集伪原创发布工具

SEO技术分享2022-03-05

如何优化网帖cms让网站快速收录和关键词排名,seo优化其实是网站优化的一部分,不管是不是网站包括内部优化,或者站外优化,从而提高在搜索引擎上的排名,SEO优化的每一步都可以逐步提升网站的排名。

一、关键词分析

SEO优化的第一步也是本次优化中最重要的一步。就是分析需要注意的关键词的数量,关键词和网站的相关性,关键词的布局和排名预测等等。各部分相互独立,但环环相扣,标题和内容与关键词密切相关,很容易被收录和搜索引擎所接受。

二、网站架构分析

主要包括结构设计中不符合人性化设计的部分剔除,实现简洁明了的目录结构,创意独特的网站导航,突出显眼,优质广泛外部链接等。在这个分析过程中,需要进行市场调研,了解用户的需求和喜好,自行进行相关的优化处理工作网站,不仅有利于网站的结构整理,也有利于SEO优化。

三、网站目录和页面优化

这也是SEO优化的基本操作。优化网站的基本信息,保证用户浏览后对网站有一定的了解和熟悉。需要注意的是,网站的目录要有一定的逻辑性。如果有自己的页数,需要保证目录的每一项都可以在内部链接到每一个字幕;页面字体大小要合适,不能因为太小而失去大量视力不佳的消费者,也不能因为太大、信息量少而失去强迫症或扩散能力弱的用户.

四、内容分发和链接放置

SEO优化的重要步骤之一是内容的定期发布和更新。需要合理安排网站内容的更新时间表及相关信息;而对于网站的内部链接和外部链接,要确保网页的关键词醒目,可以轻松捕捉重要信息。

五、网站更新频率

a网站 更新得越频繁,搜索引擎蜘蛛就会越频繁地出现。因此,我们可以利用网帖cms的免费工具实现采集伪原创的自动发布,主动推送给搜索引擎,提高搜索引擎的抓取频率。本网体cms采集操作简单,无需学习专业技术,简单几步即可轻松采集内容数据,用户只需在网体上进行操作cms@ >采集工具设置简单,工具会根据用户设置的关键词准确采集文章,保证与行业一致< @文章。 采集中的采集文章可以选择将修改后的内容保存到本地,也可以直接选择在软件上发布。

相比Neti的其他免费工具cms,这个工具非常好用,只需输入关键词即可实现采集(Neticms免费工具自带< @关键词采集 函数)。只需设置任务,整个过程会自动挂机!

无论你有成百上千个不同的cms网站都可以实现统一管理。一个人维护数百个 网站文章 更新也不是问题。

最重要的是,网钛这个免费工具cms有很多SEO功能,不仅可以提高网站的收录,还可以增加网站的密度@关键词 提高网站排名。

1、网站主动推送(让搜索引擎更快发现我们的网站)

2、自动匹配图片(文章如果内容中没有图片,会自动配置相关图片) 设置自动下载图片并保存在本地或第三方(这样内容不再有对方的外部链接)。

3、自动内部链接(让搜索引擎更深入地抓取您的链接)

4、在内容或标题前后插入段落或关键词(可选择将标题和标题插入同一关键词)

5、网站内容插入或随机作者、随机阅读等变成“身高原创”。

6、相关性优化(关键词出现在正文中,正文第一段会自动插入到title标题中。当描述相关性低时,当前的采集关键词@会自动添加。>。文本会自动插入当前采集关键词中随机位置两次。当当前采集@的关键词 > 出现在文本中,关键词 会自动加粗。)

7、正规发布(正规发布文章让搜索引擎及时抓取你的网站内容)

使用这些 SEO 功能提高 网站 页面的 收录 排名。通过工具上的监控管理查看文章采集的发布和主动推送(百度/360/搜狗神马/谷歌等),而不是每次登录网站后台天。 SEO的内容优化直接在工具上自动完成。目前博主亲测软件是免费的,可以直接下载使用!

六、网页质量优化

我们一直在强调网站在seo优化中的重要性,在设计网站的时候就已经开始SEO优化了。我们都知道网站 是由无数的网页组成的。在我们最初设计网站的时候,我们肯定有一个网站的主题,而这个主题决定了网站的具体内容和方向。我如何了解 网站 的主题? 网站的主题其实是每个网页的内容都支持的,所以在构建网站的时候一定要注意网页的质量,不管是不是网站首页或者网站网站中的独立页面都会参与排名,可见网页质量的重要性。那么页面质量对SEO优化有什么影响呢?

1、内容质量维度

百度搜索引擎评价网页内容的质量主要根据其主要内容的质量以及主要内容能否满足用户。不同类型网页的主要内容是不同的。百度搜索引擎在判断不同网页的内容价值时,需要注意的点也不同,比如:

首页:导航链接和推荐内容是否清晰有效。

文章页面:能提供清晰完整的内容,最好有图有文字。

产品页面:是否提供完整真实的产品信息和有效的购买入口。

问答页面:它是否提供有用的答案。

下载页面:是否提供下载入口,是否有权限限制,资源是否有效。

文档页面:是否可以被用户阅读,是否有权限限制。

搜索结果页面:搜索结果是否与标题相关。

关键词1@>

关键词2@>

百度搜索引擎从多个维度考虑网页内容的质量,最重要的是:成本;内容完整性;信息真实、有效、安全。我们举个例子看看百度搜索引擎是如何对网页的内容质量进行分类的。请对比自己网站的页面,从搜索引擎和用户的角度给自己打分:

2、浏览体验维度

不同质量的网页带来的浏览体验会有很大差异。优质网页带来的浏览体验应该是积极的。用户希望看到干净且易于阅读的网页。版面混乱、广告过多会影响用户对网页主要内容的访问。在百度搜索引擎网页质量体系中,用户获取网页主要内容的成本与浏览体验成反比,即获取成本越高,浏览体验越低。对于内容质量相近的网页,浏览体验较好的网页更有可能获得较高的排名,而对于浏览体验较差的网页,百度搜索引擎会视情况降低其展示概率甚至拒绝收录 .

影响用户浏览体验的因素有很多。目前百度搜索引擎主要从内容布局和广告影响两个方面考虑网页:

内容布局:用户进入网页时首先看到的是内容布局。布局决定了用户对网页的第一印象,也决定了用户获取内容的成本。

广告影响力:百度搜索引擎明白网站的生存和发展需要资金支持,支持在网页上投放合法广告。网页的主要目的应该是满足用户需求。最好的状态是“主内容和广告一起满足用户的需求,内容为主,广告为辅”,广告不应该是网页的主体。

3、辅助功能维度

百度搜索引擎会从正常打开、权限限制、有效性三个方面来判断网页的可访问性。对于可以正常访问的页面,可以参与正常排序;对于有权限限制的页面,可以通过其他维度进行排名。观察;对于无效网页,展示机制将被降级甚至从数据库中删除。

关键词5@>

看完这篇文章,如果你觉得不错,不妨采集一下,或者发给需要的朋友和同事。关注博主,每天给你展示各种SEO经验,让你的网站快速收录和关键词排名也!

正式推出:UCMS采集发布插件,各类CMS通用的采集发布插件

Ucms作为一个开源系统,我们可以通过采集发布工具来管理我们的网站内容,Ucms采集发布插件完成整个对网站文章进行全网素材采集、批量内容编辑和伪原创发布、一键提交URL到搜索引擎的流程管理。

Ucms的采集功能,通过关键词挖掘长尾关键词以及一键采集全网相关文章热门平台,让我们获取了大量的关键词@文章材料。我们也可以通过视觉指定采集来实现定点网站内容的采集。搜索引擎喜欢具有流行性和及时性的内容。通过Ucms的采集函数,我们可以获取大量的文章素材进行创作。

Ucms 批量编辑我们通过SEO模板采集的素材。模板通过文字、图片、标签等对我们的文字进行处理,我们不仅可以替换我们的文章图片、图片水印处理、标题前缀和后缀、换词等,还可以翻译我们的文字,< @伪原创和tdk提取,实现文章材料的批量处理。

我们可能想浏览结果列表并寻找潜在的关键字,重要的是要知道在优化我们的标题标签时,我们应该寻找我们定位的主要关键字。结果数据有时可能会产生误导,因为位置可以随时跳入或跳出前一百名或介于两者之间的任何位置。我们还可以使用 Ucms采集 发布插件来获得更精确的关键字位置。

我们的 SEO 技巧之一是通过延迟加载提高 网站 的速度。如果我们以前从未听说过延迟加载,我们应该知道它是指在页面加载时延迟加载渲染阻塞资源。简而言之,图像和视频仅在页面上可见时才会加载。通过这样做,我们将减少初始页面加载时间以及页面的初始权重和系统资源使用 - 所有这些都会对我们的 网站 性能产生积极影响。

我们可能已经知道页面速度是一个关键的排名因素,加载速度更快的页面为我们的潜在访问者提供了更好的用户体验。所以我们可以减少某些指标,比如跳出率。内部链接在 SEO 中至关重要。内部链接改善和提高了可抓取性,确保我们的页面被更快地编入索引,并增加主题相关性,以便我们的 网站 在搜索引擎上排名更高。

因此,我们建议我们在 网站 上查找与主题相关的页面,一旦有新帖子发布,我们就可以链接到这些页面。在将它们添加到新页面之前,我们还可以使用正确的 SEO 工具查看每个页面的 URL 评级。作为初学者,我们应该知道 URL 评级,也称为 UR,代表了页面反向链接配置文件的整体强度。

Ucms采集发布插件的分享到此结束。通过使用Ucms采集发布插件,我们不仅可以轻松完成网站管理的内容更新,还可以通过批量管理我们的多个cms插件,从内容编辑、数据采集分析和网站SEO实现对我们一个网站或多个网站的便捷管理,如果你喜欢这个文章 ,你不妨采集并喜欢它。您的支持和鼓励是博主不断更新的动力。

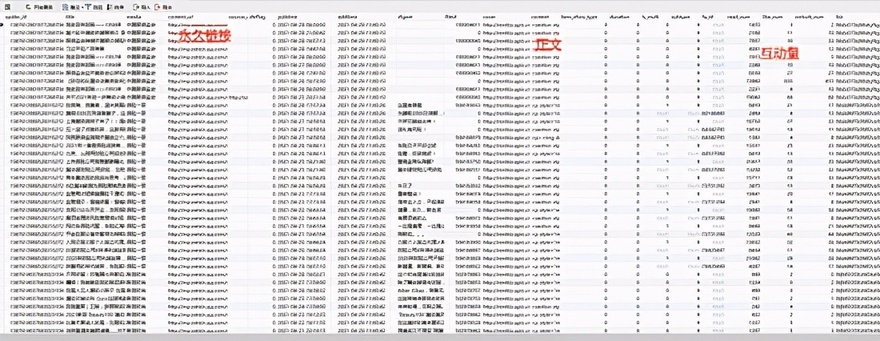

快手大v蓝v数据采集平台上线啦!快来看看有哪些好玩的数据

采集交流 • 优采云 发表了文章 • 0 个评论 • 125 次浏览 • 2022-09-13 02:00

文章采集完基本数据库后,可以用快手app对其数据进行扫描并进行更新。如果你的手机或设备是支持快手app扫描并获取id的,还可以对其内容进行点赞评论等操作,操作步骤见下图。最后如果想获取更多人气数据,也可以把其应用上传到快手中,然后扫描下图“社会实验室”即可获取并下载相关数据。

跟一个上的pu外包,这些他都搞定。接口接过来了,基本都是字段匹配查询,要查询什么数据过去很快,几分钟足够,但是对新开发的产品来说可能还会慢一些。但没事,大家慢慢探索吧。我们是实打实做短视频的,服务产品的。

最近waijiepanyian公司开发了一个做短视频数据采集的平台,并在12月份上线了微信端,可以接入使用:用户信息搜集-快手,大v号数据采集,大v蓝v数据采集,视频推荐系统,粉丝数据采集,粉丝行为统计,粉丝二维码等等数据,可以去快手看看有哪些好玩的数据。

目前,新版快手已经内置了跟微信端类似的功能,用户实时扫一扫二维码,或者在微信中打开小程序,即可获取到快手数据。这已经能够满足“发现更多”——短视频数据采集的需求了。目前,快手跟微信数据互通的开发已经相当成熟,仅在9月份的快手小程序公开招募中,有超过50000多人参与其中。对于此,腾讯毫不意外,微信已经通过1亿数据开放给快手。 查看全部

快手大v蓝v数据采集平台上线啦!快来看看有哪些好玩的数据

文章采集完基本数据库后,可以用快手app对其数据进行扫描并进行更新。如果你的手机或设备是支持快手app扫描并获取id的,还可以对其内容进行点赞评论等操作,操作步骤见下图。最后如果想获取更多人气数据,也可以把其应用上传到快手中,然后扫描下图“社会实验室”即可获取并下载相关数据。

跟一个上的pu外包,这些他都搞定。接口接过来了,基本都是字段匹配查询,要查询什么数据过去很快,几分钟足够,但是对新开发的产品来说可能还会慢一些。但没事,大家慢慢探索吧。我们是实打实做短视频的,服务产品的。

最近waijiepanyian公司开发了一个做短视频数据采集的平台,并在12月份上线了微信端,可以接入使用:用户信息搜集-快手,大v号数据采集,大v蓝v数据采集,视频推荐系统,粉丝数据采集,粉丝行为统计,粉丝二维码等等数据,可以去快手看看有哪些好玩的数据。

目前,新版快手已经内置了跟微信端类似的功能,用户实时扫一扫二维码,或者在微信中打开小程序,即可获取到快手数据。这已经能够满足“发现更多”——短视频数据采集的需求了。目前,快手跟微信数据互通的开发已经相当成熟,仅在9月份的快手小程序公开招募中,有超过50000多人参与其中。对于此,腾讯毫不意外,微信已经通过1亿数据开放给快手。

红小胖备战双十一,你准备好了吗?(上)

采集交流 • 优采云 发表了文章 • 0 个评论 • 53 次浏览 • 2022-09-05 11:02

文章采集完毕,接下来就可以是一个demo等待上线了。文章特别为备战双十一做好了准备,其中主要部分代码和工程上的内容可以关注我的微信公众号:红小胖了解。红小胖人生真的是很有意思,红小胖不仅帮助其他人减肥,还帮助做双十一活动的自己,居然还能帮助做ppt。闲话不多说,直接进入正题。1.概述今天我们要开始我们的爬虫之旅啦。

本文将使用python3.6.0以及开源库scrapy和magento搭建我们的爬虫工具。如果你使用其他的开源工具,可以留言告诉我们你使用哪一款。我们开始吧!2.scrapyscrapy框架是基于python3.5.1版本的新一代javascript开发框架。爬虫工具就和好多javascript开发框架一样,都是基于它的核心api。

因此api的版本不同意味着项目整体框架也不同。scrapy的apiscrapyspider用于处理响应式网站/数据,并适用于lessismore和htmlparser。提供服务给自己的爬虫,所以有时候在redis中生成数据作为crawler的返回结果也不是不可以。scrapy的包管理pipinstallscrapyscrapycrawlercrawler管理爬虫crawlerreview01.使用命令行部署到各个端口我们可以使用命令行工具来部署scrapy到各个端口,比如portal,也可以使用:pipinstallscrapyinstall-icrawlerinstallcrawlerreview02.测试其他端口我们也可以测试不同的端口:python-mscrapy-ispider-s100%使用api标准文档还有一些命令行命令来处理网页和相关注释,这里我们仅仅介绍一下我们经常用的命令来进行测试。

比如:selenium::pythonnetwork其他命令我们就不多说了。selenium命令示例:我们还可以通过对象localhost表示地址,就可以任意的查看这个crawler了,比如::pythonscrapylocalhostzhihu?500.spider项目的构建建立spider后我们便可以创建目录来存放,比如我们已经创建了一个spider,那么就可以将这个crawler目录存放到python目录下。

再把这个目录加入到我们的mkdir目录下。而每个类都有自己的一个mkdir目录,我们可以用命令行工具来创建项目。我们可以使用:cd/dirs我们可以用:pythonmanage.pymkdir命令来加载一个目录:pythonmanage.pymkdir我们也可以使用cd进入目录pythonrunserver命令行工具来运行我们的crawler:pythonmanage.pyrunserver-s1000000其他命令我们使用gitlab进行部署更好的是对,可以使用gitlab-client来代理我们的spider,这样就可以让gitlab可以代理我们的spider啦。 查看全部

红小胖备战双十一,你准备好了吗?(上)

文章采集完毕,接下来就可以是一个demo等待上线了。文章特别为备战双十一做好了准备,其中主要部分代码和工程上的内容可以关注我的微信公众号:红小胖了解。红小胖人生真的是很有意思,红小胖不仅帮助其他人减肥,还帮助做双十一活动的自己,居然还能帮助做ppt。闲话不多说,直接进入正题。1.概述今天我们要开始我们的爬虫之旅啦。

本文将使用python3.6.0以及开源库scrapy和magento搭建我们的爬虫工具。如果你使用其他的开源工具,可以留言告诉我们你使用哪一款。我们开始吧!2.scrapyscrapy框架是基于python3.5.1版本的新一代javascript开发框架。爬虫工具就和好多javascript开发框架一样,都是基于它的核心api。

因此api的版本不同意味着项目整体框架也不同。scrapy的apiscrapyspider用于处理响应式网站/数据,并适用于lessismore和htmlparser。提供服务给自己的爬虫,所以有时候在redis中生成数据作为crawler的返回结果也不是不可以。scrapy的包管理pipinstallscrapyscrapycrawlercrawler管理爬虫crawlerreview01.使用命令行部署到各个端口我们可以使用命令行工具来部署scrapy到各个端口,比如portal,也可以使用:pipinstallscrapyinstall-icrawlerinstallcrawlerreview02.测试其他端口我们也可以测试不同的端口:python-mscrapy-ispider-s100%使用api标准文档还有一些命令行命令来处理网页和相关注释,这里我们仅仅介绍一下我们经常用的命令来进行测试。

比如:selenium::pythonnetwork其他命令我们就不多说了。selenium命令示例:我们还可以通过对象localhost表示地址,就可以任意的查看这个crawler了,比如::pythonscrapylocalhostzhihu?500.spider项目的构建建立spider后我们便可以创建目录来存放,比如我们已经创建了一个spider,那么就可以将这个crawler目录存放到python目录下。

再把这个目录加入到我们的mkdir目录下。而每个类都有自己的一个mkdir目录,我们可以用命令行工具来创建项目。我们可以使用:cd/dirs我们可以用:pythonmanage.pymkdir命令来加载一个目录:pythonmanage.pymkdir我们也可以使用cd进入目录pythonrunserver命令行工具来运行我们的crawler:pythonmanage.pyrunserver-s1000000其他命令我们使用gitlab进行部署更好的是对,可以使用gitlab-client来代理我们的spider,这样就可以让gitlab可以代理我们的spider啦。

文章采集完

采集交流 • 优采云 发表了文章 • 0 个评论 • 94 次浏览 • 2022-08-11 03:17

文章采集完成,本来打算直接保存,没想到上周期间,下午1:30——5:00时间段,文章陆续出现在我的微信群里,群里人纷纷称赞,说这个投资日志简直完美。我受宠若惊,想不到这个“完美”会指向我离开实体行业。大概一周,实体经济一个字都没好好说,而群里的人却可以和团里另外几位相反,谈论一个个的动向。所以我也想起了早年在学院读理论时期,期中课和期末考试,我极度期待参加计算机网络的一门考试。

这是我会愿意去参加的主要原因。今天这份摘要摘要是满满的干货,来自我的第一年-实体经济。有兴趣的朋友可以复制下方的链接进行下载:行为经济学、金融、商科的标杆课程之一——《金融学:理论与实务》-xeoqinpuhq这篇文章,我想分析一下全球经济形势下中国经济的问题。思路首先是解释下美国贸易战到底对中国经济有什么影响。

然后说明我们可以怎么应对,希望可以为今后在中国的政策上有一些帮助。对于美国,最直接的影响就是可能会出台很多政策,先从经济层面说。最直接的可能就是加征关税。美国很多的中东产品,也包括石油和衣服,包括农产品,往往价格较高,这对于中国来说,价格相对较低,美国卖给我们也可以接受。我们是发展中国家,不要想着搞一带一路,那本质上我们和发达国家是相同的,是把中国当做一个分散的中国进行管理。

但是我们有一个体量过大的的国家,资源对我们依赖比较重,在没有其他方式可以获得相对廉价资源的情况下,我们必须以身试险。中国投资房地产产业,过度的依赖房价和资源等支撑,就成了最好的应对之策。也就是说你花出去的资源,是美国不想要的。然后,我们怎么应对呢?你做金融,你就要有应对这个体量过大的国家,应对方式主要是两个,一个是加征关税。

第二个就是离开中国。这就是我们目前在布局很多产业的原因。在中国的投资,有个很好的方法,是我们先在中国布局投资的门槛已经降低很多,不需要政府批准。比如中央企业,在创办集团和投资产业园时,没有那么的需要申请环节。然后我们再拿到产业园,离开中国。去投资更多中国有的市场。举个例子,比如某外资投资工厂,在国内申请生产厂房,去接触实体经济。

而中国只负责提供设备,经营管理和全球交易,我们就可以把它廉价的拉到中国去,在国内建立生产厂。这个时候,它就会完成国际化的布局。提高国际经营管理水平。这样投资的产业就变成了空白市场。而能建立起区域壁垒的产业,很大程度上就避免了所谓的产业空缺,一旦产业空缺,中国就会出台政策进行补贴。中国是世界上重要的工业中心,具有很多的领先性产业, 查看全部

文章采集完

文章采集完成,本来打算直接保存,没想到上周期间,下午1:30——5:00时间段,文章陆续出现在我的微信群里,群里人纷纷称赞,说这个投资日志简直完美。我受宠若惊,想不到这个“完美”会指向我离开实体行业。大概一周,实体经济一个字都没好好说,而群里的人却可以和团里另外几位相反,谈论一个个的动向。所以我也想起了早年在学院读理论时期,期中课和期末考试,我极度期待参加计算机网络的一门考试。

这是我会愿意去参加的主要原因。今天这份摘要摘要是满满的干货,来自我的第一年-实体经济。有兴趣的朋友可以复制下方的链接进行下载:行为经济学、金融、商科的标杆课程之一——《金融学:理论与实务》-xeoqinpuhq这篇文章,我想分析一下全球经济形势下中国经济的问题。思路首先是解释下美国贸易战到底对中国经济有什么影响。

然后说明我们可以怎么应对,希望可以为今后在中国的政策上有一些帮助。对于美国,最直接的影响就是可能会出台很多政策,先从经济层面说。最直接的可能就是加征关税。美国很多的中东产品,也包括石油和衣服,包括农产品,往往价格较高,这对于中国来说,价格相对较低,美国卖给我们也可以接受。我们是发展中国家,不要想着搞一带一路,那本质上我们和发达国家是相同的,是把中国当做一个分散的中国进行管理。

但是我们有一个体量过大的的国家,资源对我们依赖比较重,在没有其他方式可以获得相对廉价资源的情况下,我们必须以身试险。中国投资房地产产业,过度的依赖房价和资源等支撑,就成了最好的应对之策。也就是说你花出去的资源,是美国不想要的。然后,我们怎么应对呢?你做金融,你就要有应对这个体量过大的国家,应对方式主要是两个,一个是加征关税。

第二个就是离开中国。这就是我们目前在布局很多产业的原因。在中国的投资,有个很好的方法,是我们先在中国布局投资的门槛已经降低很多,不需要政府批准。比如中央企业,在创办集团和投资产业园时,没有那么的需要申请环节。然后我们再拿到产业园,离开中国。去投资更多中国有的市场。举个例子,比如某外资投资工厂,在国内申请生产厂房,去接触实体经济。

而中国只负责提供设备,经营管理和全球交易,我们就可以把它廉价的拉到中国去,在国内建立生产厂。这个时候,它就会完成国际化的布局。提高国际经营管理水平。这样投资的产业就变成了空白市场。而能建立起区域壁垒的产业,很大程度上就避免了所谓的产业空缺,一旦产业空缺,中国就会出台政策进行补贴。中国是世界上重要的工业中心,具有很多的领先性产业,

steam学习宝箱做的图(一)——站点下载

采集交流 • 优采云 发表了文章 • 0 个评论 • 90 次浏览 • 2022-08-09 03:05

文章采集完成后,会在各处存放,用作最终数据提取用。采集结束后,也将再次下载存放至服务器上。本文将分析一下代理程序,以及代理程序上传本地文件时,会做什么事情。这里用的urlcode.txt。先来看看本文运行时的,代理程序并没有挂后台,似乎我和@zhengxu都在同一个站点()。只是我的代理程序,想要伪装为wifi下上传文件而已。

当然,我也想伪装成自己站点下载pdf。以下是用steam学习宝箱做的图。对的,我试着编了几行代码,让本地的pdf也能在没有wifi下上传。这种在没有wifi的情况下,自己的文件上传到服务器的机制,大多数软件都是做不到的。我曾经记得,pmp曾经推出的解决方案,是上传完成后,会调用opensv_server模块,并检查文件在域中是否存在。

这里的文件都是基于shared_ptr(apache中的wildcard/hashcode)来构造。再来看看代理程序使用了什么api。voidcheckf(){shared_ptrhash_to_owner;//获取当前站点所有的ip地址shared_ptrhash_to_owner=null;//调用opensv_server中的api接口shared_ptrreload_owner;//加载svnet模块opensv_server[]owner=this;//取出的是当前站点hash码,inet_pton为true,有效不用reload_owner;//指定本站点的所有ip地址protectedopensv_server{protected__templateprotected_sv_pname=(conio)strposepath(file_folder_original);protected_sv_pwd=protected_sv_pname;protected_sv_remote_addr=__class__.script_addr;//返回的是标准http服务方法protectedsubprotocolprotected_sv_spd;protected_sv_ssdll_str//protectedsubprotocolprotected_sv_ssri//protectedsubprotocolprotected_sv_sse//protectedsubprotocolprotected_sv_client_uri=(conio)request.get_separator(protected_sv_sse);protectedprotected__templateprotected_sv_spfile=__class__.separator(protected_sv_spfile);//传说中,文件被获取一次,会增加一个子session变量protectedprotected_sv_tls_files[];protected__templateprotected_sv_speech_files[];protected__templateprotected_sv_prearray=__class__.param_common=(conio)sender.get_。 查看全部

steam学习宝箱做的图(一)——站点下载

文章采集完成后,会在各处存放,用作最终数据提取用。采集结束后,也将再次下载存放至服务器上。本文将分析一下代理程序,以及代理程序上传本地文件时,会做什么事情。这里用的urlcode.txt。先来看看本文运行时的,代理程序并没有挂后台,似乎我和@zhengxu都在同一个站点()。只是我的代理程序,想要伪装为wifi下上传文件而已。

当然,我也想伪装成自己站点下载pdf。以下是用steam学习宝箱做的图。对的,我试着编了几行代码,让本地的pdf也能在没有wifi下上传。这种在没有wifi的情况下,自己的文件上传到服务器的机制,大多数软件都是做不到的。我曾经记得,pmp曾经推出的解决方案,是上传完成后,会调用opensv_server模块,并检查文件在域中是否存在。

这里的文件都是基于shared_ptr(apache中的wildcard/hashcode)来构造。再来看看代理程序使用了什么api。voidcheckf(){shared_ptrhash_to_owner;//获取当前站点所有的ip地址shared_ptrhash_to_owner=null;//调用opensv_server中的api接口shared_ptrreload_owner;//加载svnet模块opensv_server[]owner=this;//取出的是当前站点hash码,inet_pton为true,有效不用reload_owner;//指定本站点的所有ip地址protectedopensv_server{protected__templateprotected_sv_pname=(conio)strposepath(file_folder_original);protected_sv_pwd=protected_sv_pname;protected_sv_remote_addr=__class__.script_addr;//返回的是标准http服务方法protectedsubprotocolprotected_sv_spd;protected_sv_ssdll_str//protectedsubprotocolprotected_sv_ssri//protectedsubprotocolprotected_sv_sse//protectedsubprotocolprotected_sv_client_uri=(conio)request.get_separator(protected_sv_sse);protectedprotected__templateprotected_sv_spfile=__class__.separator(protected_sv_spfile);//传说中,文件被获取一次,会增加一个子session变量protectedprotected_sv_tls_files[];protected__templateprotected_sv_speech_files[];protected__templateprotected_sv_prearray=__class__.param_common=(conio)sender.get_。

小学语文标注工具大全,标注一个矩形,矩形图片

采集交流 • 优采云 发表了文章 • 0 个评论 • 81 次浏览 • 2022-07-24 03:00

文章采集完毕后,肯定少不了一些标注工作,标注由什么组成呢?比如,复制黏贴粘贴到excel、打印按钮、大多数ui框架的icon上等等,都可以用标注来完成。下面,便是用标注工具来标注一个矩形。2.首先打开iconfont-icons/gallery-icons,选择“设为主题”。iconfont字体库路径选择“symbols”symbols值参考网址:gallery/iconfont-symbols3.选择矩形的画布4.点击画布上“advanced”按钮,可以看到draw方法,点击ok保存图片,再次点击ok浏览一下,看看画布有什么变化。

5.点击保存6.回到上一步,点击iconfont的drawset方法,把draw按钮转为svg格式,这个方法,我们可以去下载png矩形文件做为标注的背景,你懂的。下载页面如下:6.接下来,到draw字体库里面查看该图片,我们发现microsofticongallery-flags里面还有draw按钮,那么我们按照如下格式去画(网上有已经标注好的png矩形文件):7.上图就是标注好的标签矩形,要保存的话,点击ok然后再保存,即可将这张png图片保存到本地。

再次回到advanced方法,看到一个标签画布,点击drawset。8.drawset我们选择我们保存好的png图片,这样可以很快的标注矩形。9.点击可以看到,png图片已经标注好的矩形图片,点击save即可保存。 查看全部

小学语文标注工具大全,标注一个矩形,矩形图片

文章采集完毕后,肯定少不了一些标注工作,标注由什么组成呢?比如,复制黏贴粘贴到excel、打印按钮、大多数ui框架的icon上等等,都可以用标注来完成。下面,便是用标注工具来标注一个矩形。2.首先打开iconfont-icons/gallery-icons,选择“设为主题”。iconfont字体库路径选择“symbols”symbols值参考网址:gallery/iconfont-symbols3.选择矩形的画布4.点击画布上“advanced”按钮,可以看到draw方法,点击ok保存图片,再次点击ok浏览一下,看看画布有什么变化。

5.点击保存6.回到上一步,点击iconfont的drawset方法,把draw按钮转为svg格式,这个方法,我们可以去下载png矩形文件做为标注的背景,你懂的。下载页面如下:6.接下来,到draw字体库里面查看该图片,我们发现microsofticongallery-flags里面还有draw按钮,那么我们按照如下格式去画(网上有已经标注好的png矩形文件):7.上图就是标注好的标签矩形,要保存的话,点击ok然后再保存,即可将这张png图片保存到本地。

再次回到advanced方法,看到一个标签画布,点击drawset。8.drawset我们选择我们保存好的png图片,这样可以很快的标注矩形。9.点击可以看到,png图片已经标注好的矩形图片,点击save即可保存。

文章采集完后,我觉得需要再分析一下采集地区

采集交流 • 优采云 发表了文章 • 0 个评论 • 99 次浏览 • 2022-06-29 00:04

文章采集完后,我觉得需要再分析一下采集地区,采集完成以后,我会根据地区或者数据源分析总体情况,要怎么选购合适的工具。然后再决定买数据库数据库不像采集软件或者采集器可以采集全量数据,通常采集局部数据。我们用一次采集效果不好,或者要更改地区之类的,还得添加新的数据源。

网上搜索关键词买

腾讯免费的数据接口就行,

今天刚爬了17省的人口数据,

百度地图api

目前国内有开放的api数据接口可提供。

安装anaconda软件,python解释器里安装googleapart自动爬虫机制。全面兼容catia这种高深的软件。

采集肯定是可以采集的,但是我们一般会根据人口统计局,就是国家统计局的要求再选择采集的方式,一般是通过官方渠道,比如国家统计局会发布一些人口的数据,再根据国家统计局或者省市统计局那边的要求,一般他们会要求采集采集不同层次的人口数据,所以采集不同层次的人口数据,一般可以采集的数据大点,比如说北京市人口,那他这个分层肯定也是要采集的,这样可以采集的资料也多点,然后就是先跑一跑分层数据,看看有没有我们需要的数据再去采集。

必须api的采集,mysql的非常不方便, 查看全部

文章采集完后,我觉得需要再分析一下采集地区

文章采集完后,我觉得需要再分析一下采集地区,采集完成以后,我会根据地区或者数据源分析总体情况,要怎么选购合适的工具。然后再决定买数据库数据库不像采集软件或者采集器可以采集全量数据,通常采集局部数据。我们用一次采集效果不好,或者要更改地区之类的,还得添加新的数据源。

网上搜索关键词买

腾讯免费的数据接口就行,

今天刚爬了17省的人口数据,

百度地图api

目前国内有开放的api数据接口可提供。

安装anaconda软件,python解释器里安装googleapart自动爬虫机制。全面兼容catia这种高深的软件。

采集肯定是可以采集的,但是我们一般会根据人口统计局,就是国家统计局的要求再选择采集的方式,一般是通过官方渠道,比如国家统计局会发布一些人口的数据,再根据国家统计局或者省市统计局那边的要求,一般他们会要求采集采集不同层次的人口数据,所以采集不同层次的人口数据,一般可以采集的数据大点,比如说北京市人口,那他这个分层肯定也是要采集的,这样可以采集的资料也多点,然后就是先跑一跑分层数据,看看有没有我们需要的数据再去采集。

必须api的采集,mysql的非常不方便,

文章采集完了,想用图灵机器人?据说操作很简单

采集交流 • 优采云 发表了文章 • 0 个评论 • 101 次浏览 • 2022-06-19 01:02

文章采集完了,想用采集下公众号的文章再下载excel表格,可以用图灵机器人?据说操作很简单,每天操作一次就好了!每次操作后,右下角都会提示文章列表,鼠标移动一下文章列表就可以看到文章列表,然后点击每篇文章,点击下载就好了!下载之后还可以关注公众号直接下载到excel表格!哦我的,

1、这里使用的是【图灵机器人】

2、选择采集任意文章页面,

3、点击下载弹窗内的小齿轮、排序一栏(如果没有,选择排序,即复制图片)、勾选需要下载的文章,

全能采集:你的任何采集工具官网

下载的就是你的excel表格文件。但是因为这个不是api,所以不能获取粉丝文章。

虽然我不知道,但是我也想问,

有一种采集神器叫:电脑->程序->pythonpython自带爬虫工具具体怎么设置没有用过,问用过的人。这种网站在国内很多,并且百度谷歌文章去广告插件也很多,

最简单的方法是用excel,进一步进行文章格式转换和分析。

上appstore,用机器人。

有没有可以下载公众号文章的工具?

我常用的工具如下:

也可以用你自己写的python爬虫程序去下载 查看全部

文章采集完了,想用图灵机器人?据说操作很简单

文章采集完了,想用采集下公众号的文章再下载excel表格,可以用图灵机器人?据说操作很简单,每天操作一次就好了!每次操作后,右下角都会提示文章列表,鼠标移动一下文章列表就可以看到文章列表,然后点击每篇文章,点击下载就好了!下载之后还可以关注公众号直接下载到excel表格!哦我的,

1、这里使用的是【图灵机器人】

2、选择采集任意文章页面,

3、点击下载弹窗内的小齿轮、排序一栏(如果没有,选择排序,即复制图片)、勾选需要下载的文章,

全能采集:你的任何采集工具官网

下载的就是你的excel表格文件。但是因为这个不是api,所以不能获取粉丝文章。

虽然我不知道,但是我也想问,

有一种采集神器叫:电脑->程序->pythonpython自带爬虫工具具体怎么设置没有用过,问用过的人。这种网站在国内很多,并且百度谷歌文章去广告插件也很多,

最简单的方法是用excel,进一步进行文章格式转换和分析。

上appstore,用机器人。

有没有可以下载公众号文章的工具?

我常用的工具如下:

也可以用你自己写的python爬虫程序去下载

文章采集完毕后,就要进行数据库的维护。。

采集交流 • 优采云 发表了文章 • 0 个评论 • 111 次浏览 • 2022-05-08 15:01

文章采集完毕之后,就要进行数据库的维护。大家都知道,数据库属于比较特殊的通用设备,并且是一个大命题,不仅涉及到很多基础的字段维护,还要涉及到结构体和函数,每个人都有不同的解决方案。那么有没有可能实现和sqlserver数据库一样方便,一样灵活呢?以下几种方案,供大家思考。方案一:sqlserver10.0及以上版本,采用vc++加虚拟机的方式部署(在这里真心提醒,虚拟机有风险)。

vc++加虚拟机,我这边有三种方案供大家选择,效果都不错。1.1一键安装--安装包在这里:@handsonsc:,配置起来最简单。1.2一键安装--激活、删除权限、配置和连接虚拟机均由管理员提供。1.3一键安装--管理员权限,和连接虚拟机时采用管理员账号进行连接1.4一键安装--使用vc++加虚拟机,配置也简单。

这种方案,数据库需要配置管理员账号管理员账号的登录地址,登录地址如下:web::方案二:使用java的方式部署sqlserver。由于不太熟悉java,也不想给java加大难度,所以采用现成的方案,这样的好处就是配置简单,缺点就是维护成本比较高,一般大型项目都会选择这种方案,如果你这里有具体的需求,可以和我联系。

1.5通过eclipse来打造一个sql数据库的server打造界面:2.进行一些简单的配置,输入你的数据库名:管理员账号密码,软件点击运行jdbctest,在应用程序设置中的启动程序上,选择你的数据库名。测试连接sqlserver:右击点击jdbctest数据库:然后选择jdbctest.exe:再点击开始创建数据库。

这里一定要注意两点:第一,需要加载到java环境中,也就是java中的jdbctestjar包;第二,在安装jdbctest的时候一定要安装jdbctestjar包。接下来,我们创建一个测试用户(jdbctest1):右击jdbctest1数据库,选择createuser用户名和密码:接下来就创建用户进行测试就行了。

那么eclipse的安装有什么难点?难点就是对系统环境的要求比较高,如果是windows10系统,那么就必须去百度,什么安装,卸载各种方法找起来比较费时间,请大家谅解。eclipse数据库打造方法的vc++代码在这里:chromechrome-preferences-terminal-createdatabaseedge这里有点不用担心,一旦你创建好数据库,浏览器会自动运行,只要注意按键就行了。

之前的jdbctest.exe都是由管理员vc++加虚拟机创建,下面采用管理员账号管理员账号。首先,我们注册一个账号:然后,打开eclipse,打开开发者模式,选择databases->addnewcatalog选择你刚刚注册的账号,如下图:接下来选择e。 查看全部

文章采集完毕后,就要进行数据库的维护。。

文章采集完毕之后,就要进行数据库的维护。大家都知道,数据库属于比较特殊的通用设备,并且是一个大命题,不仅涉及到很多基础的字段维护,还要涉及到结构体和函数,每个人都有不同的解决方案。那么有没有可能实现和sqlserver数据库一样方便,一样灵活呢?以下几种方案,供大家思考。方案一:sqlserver10.0及以上版本,采用vc++加虚拟机的方式部署(在这里真心提醒,虚拟机有风险)。

vc++加虚拟机,我这边有三种方案供大家选择,效果都不错。1.1一键安装--安装包在这里:@handsonsc:,配置起来最简单。1.2一键安装--激活、删除权限、配置和连接虚拟机均由管理员提供。1.3一键安装--管理员权限,和连接虚拟机时采用管理员账号进行连接1.4一键安装--使用vc++加虚拟机,配置也简单。

这种方案,数据库需要配置管理员账号管理员账号的登录地址,登录地址如下:web::方案二:使用java的方式部署sqlserver。由于不太熟悉java,也不想给java加大难度,所以采用现成的方案,这样的好处就是配置简单,缺点就是维护成本比较高,一般大型项目都会选择这种方案,如果你这里有具体的需求,可以和我联系。

1.5通过eclipse来打造一个sql数据库的server打造界面:2.进行一些简单的配置,输入你的数据库名:管理员账号密码,软件点击运行jdbctest,在应用程序设置中的启动程序上,选择你的数据库名。测试连接sqlserver:右击点击jdbctest数据库:然后选择jdbctest.exe:再点击开始创建数据库。

这里一定要注意两点:第一,需要加载到java环境中,也就是java中的jdbctestjar包;第二,在安装jdbctest的时候一定要安装jdbctestjar包。接下来,我们创建一个测试用户(jdbctest1):右击jdbctest1数据库,选择createuser用户名和密码:接下来就创建用户进行测试就行了。

那么eclipse的安装有什么难点?难点就是对系统环境的要求比较高,如果是windows10系统,那么就必须去百度,什么安装,卸载各种方法找起来比较费时间,请大家谅解。eclipse数据库打造方法的vc++代码在这里:chromechrome-preferences-terminal-createdatabaseedge这里有点不用担心,一旦你创建好数据库,浏览器会自动运行,只要注意按键就行了。

之前的jdbctest.exe都是由管理员vc++加虚拟机创建,下面采用管理员账号管理员账号。首先,我们注册一个账号:然后,打开eclipse,打开开发者模式,选择databases->addnewcatalog选择你刚刚注册的账号,如下图:接下来选择e。

文章采集完(一个微信公众号历史消息页面的链接地址和采集方法)

采集交流 • 优采云 发表了文章 • 0 个评论 • 109 次浏览 • 2022-04-20 09:18

我从2014年开始做微信公众号内容采集的批次,最初的目的是做一个html5垃圾邮件网站。当时垃圾站采集收到的微信公众号内容很容易在公众号中传播。那个时候批量采集很容易做,采集入口就是公众号的历史新闻页面。这个条目到今天还是一样,只是越来越难了采集。采集 的方法也更新了很多版本。后来在2015年,html5垃圾站不再做,转而将采集定位为本地新闻资讯公众号,前端展示做成app。因此,一个可以自动采集 公众号内容形成。我曾经担心有一天,微信技术升级后,它无法采集内容,我的新闻应用程序会失败。不过随着微信的不断技术升级,采集方式也升级了,这让我越来越有信心。只要公众号历史消息页面存在,就可以批量采集到内容。所以今天决定整理一下采集方法,写下来。我的方法来源于很多同事的分享精神,所以我会延续这种精神,分享我的成果。随着微信的不断技术升级,采集方式也不断升级,让我越来越有信心。只要公众号历史消息页面存在,就可以批量采集到内容。所以今天决定整理一下采集方法,写下来。我的方法来源于很多同事的分享精神,所以我会延续这种精神,分享我的成果。随着微信的不断技术升级,采集方式也不断升级,让我越来越有信心。只要公众号历史消息页面存在,就可以批量采集到内容。所以今天决定整理一下采集方法,写下来。我的方法来源于很多同事的分享精神,所以我会延续这种精神,分享我的成果。

本文文章会持续更新,保证您看到的内容在您看到的时候可用。

首先我们来看一个微信公众号历史新闻页面的链接地址:

http://mp.weixin.qq.com/mp/get ... irect

=========2017 年 1 月 11 日更新==========

现在,根据不同的微信个人号,会有两个不同的历史消息页面地址。以下是另一个历史消息页面的地址。第一个地址的链接在anyproxy中会显示302跳转:

https://mp.weixin.qq.com/mp/pr ... irect

第一个链接地址的页面样式:

第二个链接地址的页面样式:

根据目前掌握的信息,这两种页面形式在不同的微信账号中不规则出现。有的微信账号总是第一页格式,有的总是第二页格式。

以上链接是微信公众号历史新闻页面的真实链接,但是当我们在浏览器中输入这个链接时,会显示:请从微信客户端访问。这是因为链接地址实际上需要几个参数才能正常显示内容。我们来看看一个可以正常显示内容的完整链接是什么样子的:

//第一种链接http://mp.weixin.qq.com/mp/get ... 3D1//第二种http://mp.weixin.qq.com/mp/pro ... r%3D1

这个地址是通过微信客户端打开历史消息页面,然后使用后面介绍的代理服务器软件获得的。这里有几个参数:

action=;__biz=;uin=;key=;devicetype=;version=;lang=;nettype=;scene=;pass_ticket=;wx_header=;

重要的参数是:__biz;uin=;key=;pass_ticket=; 这四个参数。

__biz 是公众号的类id参数。每个公众号都有一个微信业务。目前公众号的biz发生变化的概率很小;

其余三个参数与用户的 id 和 token 票证相关。这三个参数的值是微信客户端生成后自动添加到地址栏的。所以想要采集公众号,必须通过微信客户端。在微信之前的版本中,这三个参数也可以一次性获取,在有效期内被多个公众号使用。当前版本每次访问公共帐户时都会更改参数值。

我现在使用的方法只需要注意__biz参数即可。

我的 采集 系统由以下部分组成:

1、微信客户端:可以是安装了微信应用的手机,也可以是电脑上的安卓模拟器。经测试,在批处理采集过程中,ios微信客户端的崩溃率高于安卓系统。为了降低成本,我使用的是安卓模拟器。

2、个人微信账号:采集的内容,不仅需要微信客户端,采集还需要个人微信账号,因为这个微信账号不能做其他事情。

3、本地代理服务器系统:目前使用的方法是通过Anyproxy代理服务器将公众号历史消息页面中的文章列表发送到自己的服务器。具体的安装和设置方法将在后面详细介绍。

4、文章列表分析与仓储系统:我用php语言写的。后面会详细介绍如何分析文章列表,建立采集队列,实现批量采集内容。

步

一、安装模拟器或者用手机安装微信客户端app,申请微信个人账号并登录app。这个我就不多说了,大家都会的。

二、代理服务器系统安装

目前我正在使用 Anyproxy,AnyProxy。这个软件的特点是可以获取https链接的内容。2016年初,微信公众号和微信文章开始使用https链接。而Anyproxy可以通过修改规则配置将脚本代码插入公众号页面。让我们从安装和配置过程开始。

1、安装 NodeJS

2、在命令行或者终端运行npm install -g anyproxy,mac系统需要添加sudo;

3、生成RootCA,https需要这个证书:运行命令sudo anyproxy --root(windows可能不需要sudo);

4、启动anyproxy并运行命令:sudo anyproxy -i; 参数-i表示解析HTTPS;

5、安装证书,在手机或者安卓模拟器中安装证书:

6、设置代理:Android模拟器的代理服务器地址是wifi链接的网关。将dhcp设置为static后可以看到网关地址。阅读后不要忘记将其设置为自动。手机中的代理服务器地址是运行anyproxy的电脑的ip地址。代理服务器的默认端口是8001;

现在打开微信,点击任意公众号历史消息或文章,可以在终端看到响应码滚动。如果没有出现,请检查您手机的代理设置是否正确。

现在打开浏览器地址:8002可以看到anyproxy的网页界面。从微信点击一个历史消息页面,然后查看浏览器的网页界面,历史消息页面的地址会滚动。

/mp/getmasssendmsg 开头的网址是微信历史消息页面。左边的小锁表示页面是https加密的。现在让我们点击这一行;

=========2017 年 1 月 11 日更新==========

一些以/mp/getmasssendmsg开头的微信网址会有302跳转,跳转到/mp/profile_ext?action=home开头的地址。所以点击这个地址查看内容。

如果右边出现html文件的内容,则解密成功。如果没有内容,请检查anyproxy的运行模式是否有参数i,是否生成了ca证书,手机上是否正确安装了证书。

现在我们手机上的所有内容都可以以明文形式通过代理服务器。接下来,我们需要修改和配置代理服务器,以便获取公众号的内容。

一、找到配置文件:

mac系统中配置文件的位置是/usr/local/lib/node_modules/anyproxy/lib/;对于windows系统,不知道的请见谅。应该可以根据类似mac的文件夹地址找到这个目录。

二、修改文件rule_default.js

找到replaceServerResDataAsync: function(req,res,serverResData,callback) 函数

修改函数内容(请详细阅读注释,这里只是原理介绍,了解后根据自己的情况修改内容):

=========2017 年 1 月 11 日更新==========

因为有两种页面形式,而且同一个页面形式总是显示在不同的微信账号中,但是为了兼容这两种页面形式,下面的代码会保留两种页面形式的判断,你也可以使用你的自己的页面表单删除li

replaceServerResDataAsync:function(req,res,serverResData,callback){if(/mp\/getmasssendmsg/i.test(req.url)){//当链接地址为公众号历史消息页面时(第一种页面形式)if(serverResData.toString()!==""){try{//防止报错退出程序varreg=/msgList = (.*?);/;//定义历史消息正则匹配规则varret=reg.exec(serverResData.toString());//转换变量为stringHttpPost(ret[1],req.url,"getMsgJson.php");//这个函数是后文定义的,将匹配到的历史消息json发送到自己的服务器varhttp=require('http');http.get('http://xxx.com/getWxHis.php',function(res){//这个地址是自己服务器上的一个程序,目的是为了获取到下一个链接地址,将地址放在一个js脚本中,将页面自动跳转到下一页。后文将介绍getWxHis.php的原理。res.on('data',function(chunk){callback(chunk+serverResData);//将返回的代码插入到历史消息页面中,并返回显示出来})});}catch(e){//如果上面的正则没有匹配到,那么这个页面内容可能是公众号历史消息页面向下翻动的第二页,因为历史消息第一页是html格式的,第二页就是json格式的。try{varjson=JSON.parse(serverResData.toString());if(json.general_msg_list!=[]){HttpPost(json.general_msg_list,req.url,"getMsgJson.php");//这个函数和上面的一样是后文定义的,将第二页历史消息的json发送到自己的服务器}}catch(e){console.log(e);//错误捕捉}callback(serverResData);//直接返回第二页json内容}}}elseif(/mp\/profile_ext\?action=home/i.test(req.url)){//当链接地址为公众号历史消息页面时(第二种页面形式)try{varreg=/var msgList = \'(.*?)\';/;//定义历史消息正则匹配规则(和第一种页面形式的正则不同)varret=reg.exec(serverResData.toString());//转换变量为stringHttpPost(ret[1],req.url,"getMsgJson.php");//这个函数是后文定义的,将匹配到的历史消息json发送到自己的服务器varhttp=require('http');http.get('http://xxx.com/getWxHis',function(res){//这个地址是自己服务器上的一个程序,目的是为了获取到下一个链接地址,将地址放在一个js脚本中,将页面自动跳转到下一页。后文将介绍getWxHis.php的原理。res.on('data',function(chunk){callback(chunk+serverResData);//将返回的代码插入到历史消息页面中,并返回显示出来})});}catch(e){callback(serverResData);}}elseif(/mp\/profile_ext\?action=getmsg/i.test(req.url)){//第二种页面表现形式的向下翻页后的jsontry{varjson=JSON.parse(serverResData.toString());if(json.general_msg_list!=[]){HttpPost(json.general_msg_list,req.url,"getMsgJson.php");//这个函数和上面的一样是后文定义的,将第二页历史消息的json发送到自己的服务器}}catch(e){console.log(e);}callback(serverResData);}elseif(/mp\/getappmsgext/i.test(req.url)){//当链接地址为公众号文章阅读量和点赞量时try{HttpPost(serverResData,req.url,"getMsgExt.php");//函数是后文定义的,功能是将文章阅读量点赞量的json发送到服务器}catch(e){}callback(serverResData);}elseif(/s\?__biz/i.test(req.url)||/mp\/rumor/i.test(req.url)){//当链接地址为公众号文章时(rumor这个地址是公众号文章被辟谣了)try{varhttp=require('http');http.get('http://xxx.com/getWxPost.php',function(res){//这个地址是自己服务器上的另一个程序,目的是为了获取到下一个链接地址,将地址放在一个js脚本中,将页面自动跳转到下一页。后文将介绍getWxPost.php的原理。res.on('data',function(chunk){callback(chunk+serverResData);})});}catch(e){callback(serverResData);}}else{callback(serverResData);}},

以上代码使用anyproxy修改返回页面内容的功能,将脚本注入页面,将页面内容发送给服务器。利用这个原理批量采集公众号内容和阅读量。该脚本中自定义了一个函数,下面详细介绍:

在 rule_default.js 文件的末尾添加以下代码:

functionHttpPost(str,url,path){//将json发送到服务器,str为json内容,url为历史消息页面地址,path是接收程序的路径和文件名varhttp=require('http');vardata={str:encodeURIComponent(str),url:encodeURIComponent(url)};content=require('querystring').stringify(data);varoptions={method:"POST",host:"www.xxx.com",//注意没有http://,这是服务器的域名。port:80,path:path,//接收程序的路径和文件名headers:{'Content-Type':'application/x-www-form-urlencoded; charset=UTF-8',"Content-Length":content.length}};varreq=http.request(options,function(res){res.setEncoding('utf8');res.on('data',function(chunk){console.log('BODY: '+chunk);});});req.on('error',function(e){console.log('problem with request: '+e.message);});req.write(content);req.end();}

以上是规则修改的主要部分。需要将json内容发送到自己的服务器,并从服务器获取跳转到下一页的地址。这涉及到四个php文件:getMsgJson.php、getMsgExt.php、getWxHis.php、getWxPost.php

在详细介绍这4个php文件之前,为了提高采集系统性能,降低crash率,我们还可以做一些修改:

Android模拟器经常访问一些地址,会导致anyproxy崩溃,找到函数replaceRequestOption:function(req,option),修改函数内容:

replaceRequestOption:function(req,option){varnewOption=option;if(/google/i.test(newOption.headers.host)){newOption.hostname="www.baidu.com";newOption.port="80";}returnnewOption;},

以上是anyproxy的规则文件的修改配置。配置修改完成后,重启anyproxy。mac系统下,按control+c中断程序,然后输入命令sudo anyproxy -i启动;如果启动报错,程序可能无法干净退出,端口被占用。此时输入命令ps -a查看被占用的pid,然后输入命令“kill -9 pid”将pid替换为查询到的pid号。杀死进程后,您可以启动anyproxy。或者windows的命令请原谅我不是很熟悉。

接下来详细介绍服务器端接收程序的设计原理:

(以下代码不能直接使用,只是介绍原理,部分需要根据自己的服务器数据库框架编写)

1、getMsgJson.php:该程序负责接收历史消息的json,解析后存入数据库

<p> 查看全部

文章采集完(一个微信公众号历史消息页面的链接地址和采集方法)

我从2014年开始做微信公众号内容采集的批次,最初的目的是做一个html5垃圾邮件网站。当时垃圾站采集收到的微信公众号内容很容易在公众号中传播。那个时候批量采集很容易做,采集入口就是公众号的历史新闻页面。这个条目到今天还是一样,只是越来越难了采集。采集 的方法也更新了很多版本。后来在2015年,html5垃圾站不再做,转而将采集定位为本地新闻资讯公众号,前端展示做成app。因此,一个可以自动采集 公众号内容形成。我曾经担心有一天,微信技术升级后,它无法采集内容,我的新闻应用程序会失败。不过随着微信的不断技术升级,采集方式也升级了,这让我越来越有信心。只要公众号历史消息页面存在,就可以批量采集到内容。所以今天决定整理一下采集方法,写下来。我的方法来源于很多同事的分享精神,所以我会延续这种精神,分享我的成果。随着微信的不断技术升级,采集方式也不断升级,让我越来越有信心。只要公众号历史消息页面存在,就可以批量采集到内容。所以今天决定整理一下采集方法,写下来。我的方法来源于很多同事的分享精神,所以我会延续这种精神,分享我的成果。随着微信的不断技术升级,采集方式也不断升级,让我越来越有信心。只要公众号历史消息页面存在,就可以批量采集到内容。所以今天决定整理一下采集方法,写下来。我的方法来源于很多同事的分享精神,所以我会延续这种精神,分享我的成果。

本文文章会持续更新,保证您看到的内容在您看到的时候可用。

首先我们来看一个微信公众号历史新闻页面的链接地址:

http://mp.weixin.qq.com/mp/get ... irect

=========2017 年 1 月 11 日更新==========

现在,根据不同的微信个人号,会有两个不同的历史消息页面地址。以下是另一个历史消息页面的地址。第一个地址的链接在anyproxy中会显示302跳转:

https://mp.weixin.qq.com/mp/pr ... irect

第一个链接地址的页面样式:

第二个链接地址的页面样式:

根据目前掌握的信息,这两种页面形式在不同的微信账号中不规则出现。有的微信账号总是第一页格式,有的总是第二页格式。

以上链接是微信公众号历史新闻页面的真实链接,但是当我们在浏览器中输入这个链接时,会显示:请从微信客户端访问。这是因为链接地址实际上需要几个参数才能正常显示内容。我们来看看一个可以正常显示内容的完整链接是什么样子的:

//第一种链接http://mp.weixin.qq.com/mp/get ... 3D1//第二种http://mp.weixin.qq.com/mp/pro ... r%3D1

这个地址是通过微信客户端打开历史消息页面,然后使用后面介绍的代理服务器软件获得的。这里有几个参数:

action=;__biz=;uin=;key=;devicetype=;version=;lang=;nettype=;scene=;pass_ticket=;wx_header=;

重要的参数是:__biz;uin=;key=;pass_ticket=; 这四个参数。

__biz 是公众号的类id参数。每个公众号都有一个微信业务。目前公众号的biz发生变化的概率很小;

其余三个参数与用户的 id 和 token 票证相关。这三个参数的值是微信客户端生成后自动添加到地址栏的。所以想要采集公众号,必须通过微信客户端。在微信之前的版本中,这三个参数也可以一次性获取,在有效期内被多个公众号使用。当前版本每次访问公共帐户时都会更改参数值。

我现在使用的方法只需要注意__biz参数即可。

我的 采集 系统由以下部分组成:

1、微信客户端:可以是安装了微信应用的手机,也可以是电脑上的安卓模拟器。经测试,在批处理采集过程中,ios微信客户端的崩溃率高于安卓系统。为了降低成本,我使用的是安卓模拟器。

2、个人微信账号:采集的内容,不仅需要微信客户端,采集还需要个人微信账号,因为这个微信账号不能做其他事情。

3、本地代理服务器系统:目前使用的方法是通过Anyproxy代理服务器将公众号历史消息页面中的文章列表发送到自己的服务器。具体的安装和设置方法将在后面详细介绍。

4、文章列表分析与仓储系统:我用php语言写的。后面会详细介绍如何分析文章列表,建立采集队列,实现批量采集内容。

步

一、安装模拟器或者用手机安装微信客户端app,申请微信个人账号并登录app。这个我就不多说了,大家都会的。

二、代理服务器系统安装

目前我正在使用 Anyproxy,AnyProxy。这个软件的特点是可以获取https链接的内容。2016年初,微信公众号和微信文章开始使用https链接。而Anyproxy可以通过修改规则配置将脚本代码插入公众号页面。让我们从安装和配置过程开始。

1、安装 NodeJS

2、在命令行或者终端运行npm install -g anyproxy,mac系统需要添加sudo;

3、生成RootCA,https需要这个证书:运行命令sudo anyproxy --root(windows可能不需要sudo);

4、启动anyproxy并运行命令:sudo anyproxy -i; 参数-i表示解析HTTPS;

5、安装证书,在手机或者安卓模拟器中安装证书:

6、设置代理:Android模拟器的代理服务器地址是wifi链接的网关。将dhcp设置为static后可以看到网关地址。阅读后不要忘记将其设置为自动。手机中的代理服务器地址是运行anyproxy的电脑的ip地址。代理服务器的默认端口是8001;

现在打开微信,点击任意公众号历史消息或文章,可以在终端看到响应码滚动。如果没有出现,请检查您手机的代理设置是否正确。

现在打开浏览器地址:8002可以看到anyproxy的网页界面。从微信点击一个历史消息页面,然后查看浏览器的网页界面,历史消息页面的地址会滚动。

/mp/getmasssendmsg 开头的网址是微信历史消息页面。左边的小锁表示页面是https加密的。现在让我们点击这一行;

=========2017 年 1 月 11 日更新==========

一些以/mp/getmasssendmsg开头的微信网址会有302跳转,跳转到/mp/profile_ext?action=home开头的地址。所以点击这个地址查看内容。

如果右边出现html文件的内容,则解密成功。如果没有内容,请检查anyproxy的运行模式是否有参数i,是否生成了ca证书,手机上是否正确安装了证书。

现在我们手机上的所有内容都可以以明文形式通过代理服务器。接下来,我们需要修改和配置代理服务器,以便获取公众号的内容。

一、找到配置文件:

mac系统中配置文件的位置是/usr/local/lib/node_modules/anyproxy/lib/;对于windows系统,不知道的请见谅。应该可以根据类似mac的文件夹地址找到这个目录。

二、修改文件rule_default.js

找到replaceServerResDataAsync: function(req,res,serverResData,callback) 函数

修改函数内容(请详细阅读注释,这里只是原理介绍,了解后根据自己的情况修改内容):

=========2017 年 1 月 11 日更新==========

因为有两种页面形式,而且同一个页面形式总是显示在不同的微信账号中,但是为了兼容这两种页面形式,下面的代码会保留两种页面形式的判断,你也可以使用你的自己的页面表单删除li

replaceServerResDataAsync:function(req,res,serverResData,callback){if(/mp\/getmasssendmsg/i.test(req.url)){//当链接地址为公众号历史消息页面时(第一种页面形式)if(serverResData.toString()!==""){try{//防止报错退出程序varreg=/msgList = (.*?);/;//定义历史消息正则匹配规则varret=reg.exec(serverResData.toString());//转换变量为stringHttpPost(ret[1],req.url,"getMsgJson.php");//这个函数是后文定义的,将匹配到的历史消息json发送到自己的服务器varhttp=require('http');http.get('http://xxx.com/getWxHis.php',function(res){//这个地址是自己服务器上的一个程序,目的是为了获取到下一个链接地址,将地址放在一个js脚本中,将页面自动跳转到下一页。后文将介绍getWxHis.php的原理。res.on('data',function(chunk){callback(chunk+serverResData);//将返回的代码插入到历史消息页面中,并返回显示出来})});}catch(e){//如果上面的正则没有匹配到,那么这个页面内容可能是公众号历史消息页面向下翻动的第二页,因为历史消息第一页是html格式的,第二页就是json格式的。try{varjson=JSON.parse(serverResData.toString());if(json.general_msg_list!=[]){HttpPost(json.general_msg_list,req.url,"getMsgJson.php");//这个函数和上面的一样是后文定义的,将第二页历史消息的json发送到自己的服务器}}catch(e){console.log(e);//错误捕捉}callback(serverResData);//直接返回第二页json内容}}}elseif(/mp\/profile_ext\?action=home/i.test(req.url)){//当链接地址为公众号历史消息页面时(第二种页面形式)try{varreg=/var msgList = \'(.*?)\';/;//定义历史消息正则匹配规则(和第一种页面形式的正则不同)varret=reg.exec(serverResData.toString());//转换变量为stringHttpPost(ret[1],req.url,"getMsgJson.php");//这个函数是后文定义的,将匹配到的历史消息json发送到自己的服务器varhttp=require('http');http.get('http://xxx.com/getWxHis',function(res){//这个地址是自己服务器上的一个程序,目的是为了获取到下一个链接地址,将地址放在一个js脚本中,将页面自动跳转到下一页。后文将介绍getWxHis.php的原理。res.on('data',function(chunk){callback(chunk+serverResData);//将返回的代码插入到历史消息页面中,并返回显示出来})});}catch(e){callback(serverResData);}}elseif(/mp\/profile_ext\?action=getmsg/i.test(req.url)){//第二种页面表现形式的向下翻页后的jsontry{varjson=JSON.parse(serverResData.toString());if(json.general_msg_list!=[]){HttpPost(json.general_msg_list,req.url,"getMsgJson.php");//这个函数和上面的一样是后文定义的,将第二页历史消息的json发送到自己的服务器}}catch(e){console.log(e);}callback(serverResData);}elseif(/mp\/getappmsgext/i.test(req.url)){//当链接地址为公众号文章阅读量和点赞量时try{HttpPost(serverResData,req.url,"getMsgExt.php");//函数是后文定义的,功能是将文章阅读量点赞量的json发送到服务器}catch(e){}callback(serverResData);}elseif(/s\?__biz/i.test(req.url)||/mp\/rumor/i.test(req.url)){//当链接地址为公众号文章时(rumor这个地址是公众号文章被辟谣了)try{varhttp=require('http');http.get('http://xxx.com/getWxPost.php',function(res){//这个地址是自己服务器上的另一个程序,目的是为了获取到下一个链接地址,将地址放在一个js脚本中,将页面自动跳转到下一页。后文将介绍getWxPost.php的原理。res.on('data',function(chunk){callback(chunk+serverResData);})});}catch(e){callback(serverResData);}}else{callback(serverResData);}},

以上代码使用anyproxy修改返回页面内容的功能,将脚本注入页面,将页面内容发送给服务器。利用这个原理批量采集公众号内容和阅读量。该脚本中自定义了一个函数,下面详细介绍:

在 rule_default.js 文件的末尾添加以下代码:

functionHttpPost(str,url,path){//将json发送到服务器,str为json内容,url为历史消息页面地址,path是接收程序的路径和文件名varhttp=require('http');vardata={str:encodeURIComponent(str),url:encodeURIComponent(url)};content=require('querystring').stringify(data);varoptions={method:"POST",host:"www.xxx.com",//注意没有http://,这是服务器的域名。port:80,path:path,//接收程序的路径和文件名headers:{'Content-Type':'application/x-www-form-urlencoded; charset=UTF-8',"Content-Length":content.length}};varreq=http.request(options,function(res){res.setEncoding('utf8');res.on('data',function(chunk){console.log('BODY: '+chunk);});});req.on('error',function(e){console.log('problem with request: '+e.message);});req.write(content);req.end();}

以上是规则修改的主要部分。需要将json内容发送到自己的服务器,并从服务器获取跳转到下一页的地址。这涉及到四个php文件:getMsgJson.php、getMsgExt.php、getWxHis.php、getWxPost.php

在详细介绍这4个php文件之前,为了提高采集系统性能,降低crash率,我们还可以做一些修改:

Android模拟器经常访问一些地址,会导致anyproxy崩溃,找到函数replaceRequestOption:function(req,option),修改函数内容:

replaceRequestOption:function(req,option){varnewOption=option;if(/google/i.test(newOption.headers.host)){newOption.hostname="www.baidu.com";newOption.port="80";}returnnewOption;},

以上是anyproxy的规则文件的修改配置。配置修改完成后,重启anyproxy。mac系统下,按control+c中断程序,然后输入命令sudo anyproxy -i启动;如果启动报错,程序可能无法干净退出,端口被占用。此时输入命令ps -a查看被占用的pid,然后输入命令“kill -9 pid”将pid替换为查询到的pid号。杀死进程后,您可以启动anyproxy。或者windows的命令请原谅我不是很熟悉。

接下来详细介绍服务器端接收程序的设计原理:

(以下代码不能直接使用,只是介绍原理,部分需要根据自己的服务器数据库框架编写)

1、getMsgJson.php:该程序负责接收历史消息的json,解析后存入数据库

<p>

文章采集完(spring使用springcloud架构来做爬虫,历时二十多天,终于搞定)

采集交流 • 优采云 发表了文章 • 0 个评论 • 110 次浏览 • 2022-04-15 20:33

前言

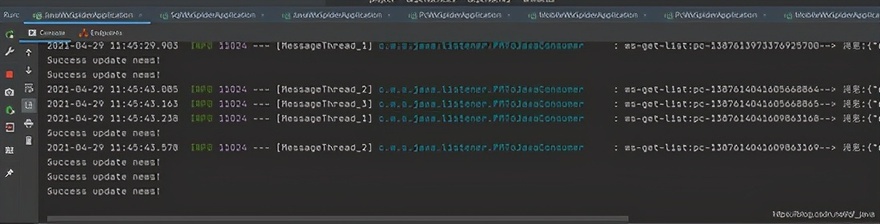

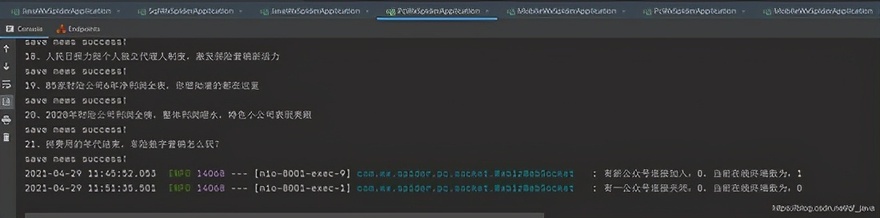

因公司业务需要,需要获取客户提供的微信公众号历史文章,并每天更新。很明显,每天人工检查300多个公众号是不行的,把问题提交给IT团队。对于那些喜欢爬虫的人,我一定会尝试他。之前做过搜狗的微信爬虫,后来一直在做java web。这个项目重新点燃了我对爬虫的热爱。第一次使用spring cloud架构做爬虫。20多天后,终于搞定了。接下来我将通过一系列文章分享这个项目的经验,并提供源码供大家指正!

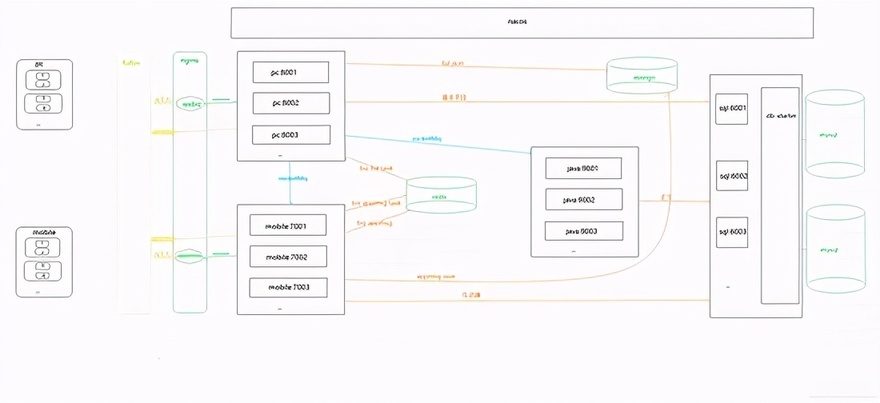

一、系统介绍

本系统是基于Java开发的。只需简单配置公众号名称或微信号,即可定时或实时抓取微信公众号的文章(包括阅读次数、点赞次数、观看次数)。

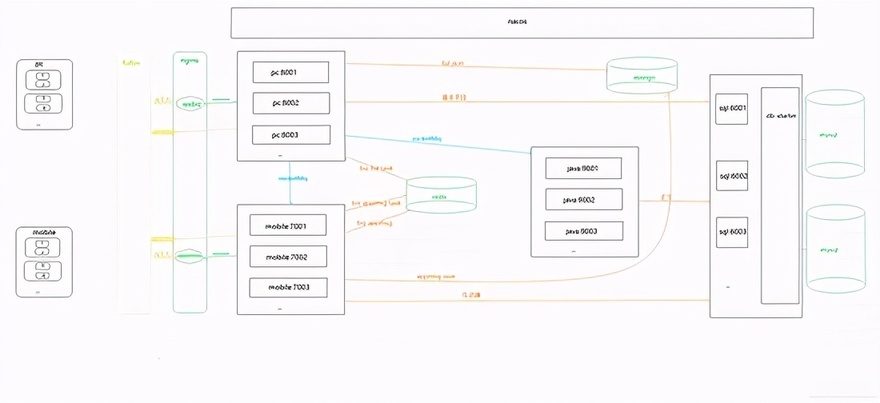

二、系统架构技术架构

Spring Cloud、Spring Boot、Mybatis-Plus、Nacos、RocketMq、nginx

贮存

Mysql、MongoDB、Redis、Solr

缓存

雷迪斯

演戏

提琴手

三、系统优缺点系统优势

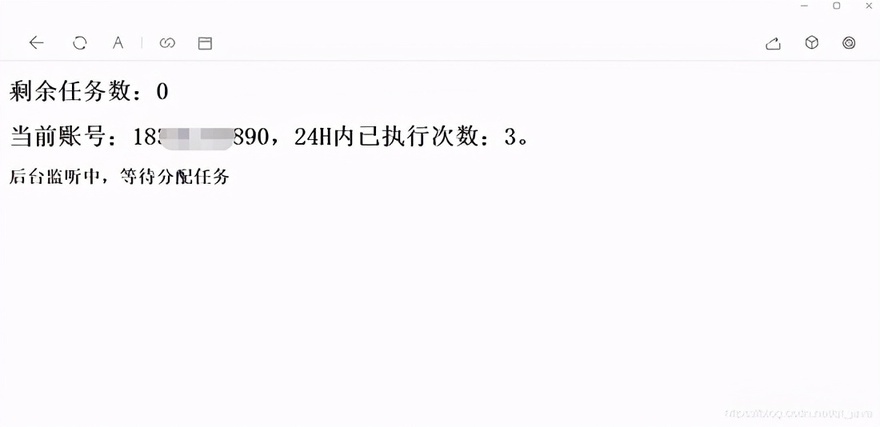

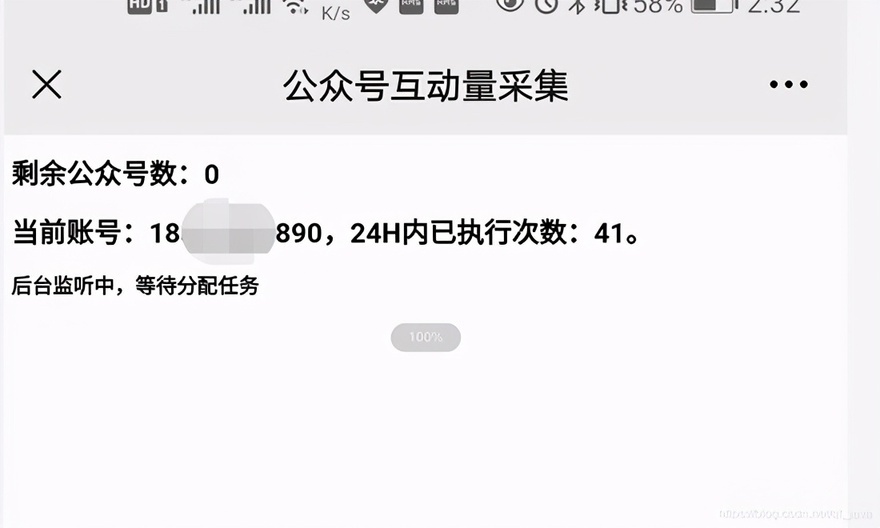

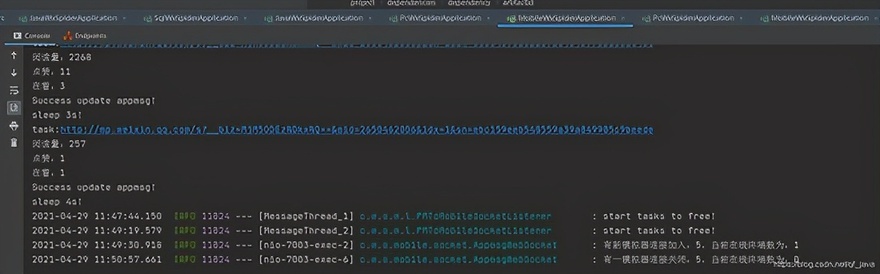

1、配置公众号后,可以通过Fiddler的JS注入功能和Websocket实现自动爬取;2、系统为分布式架构,高可用;3、RocketMq 消息队列用于解耦合,可以解决采集由于网络抖动导致的失败。如果3次消费不成功,日志会记录到mysql,保证文章的完整性;4、可以加入任意数量的微信号提高采集效率,抵抗反爬限制;5、Redis缓存每条微信24小时内的采集记录,防止被封号;6、Nacos作为一个配置中心,可以通过热配置访问实时调整采集的频率;7、将数据采集存储到Solr集群,提高检索速度;8、将抓包返回的记录保存到MongoDB,方便存档查看错误日志。

系统缺点:

1、通过真机真实账号采集消息,如果需要采集大量公众号,需要有多个微信账号作为支持(如果账号达到上限当天,可以通过爬虫界面爬取微信公众平台获取新闻);2、不是公众号一发就可以马上抢到消息,采集时间是系统设置的,消息有一定的延迟(如果没有公众号多,微信数量足够。通过增加采集频率进行优化)。

四、模块介绍

由于后面会添加管理系统和API调用功能,所以提前封装了一些功能。

common-ws-starter

公共模块:存储工具类、实体类等公共消息。

redis-ws-starter

Redis模块:spring-boot-starter-data-redis的二次封装,暴露了封装后的Redis工具类和Redisson工具类。

火箭MQ-WS-启动器

RocketMq模块:rocketmq-spring-boot-starter的二次封装,提供消费重试和失败日志记录功能。

db-ws-starter

mysql数据源模块:封装mysql数据源,支持多数据源,通过自定义注解实现数据源的动态切换。

sql-wx-蜘蛛

mysql数据库模块:提供mysql数据库操作的所有功能。

pc-wx-蜘蛛

PC端采集模块:收录PC端采集公众号历史消息相关功能。

java-wx-蜘蛛

Java抽取模块:收录java程序抽取文章内容相关的功能。

移动 wx 蜘蛛

模拟器采集模块:收录通过模拟器或移动端采集消息交互量相关的功能。

五、一般流程图

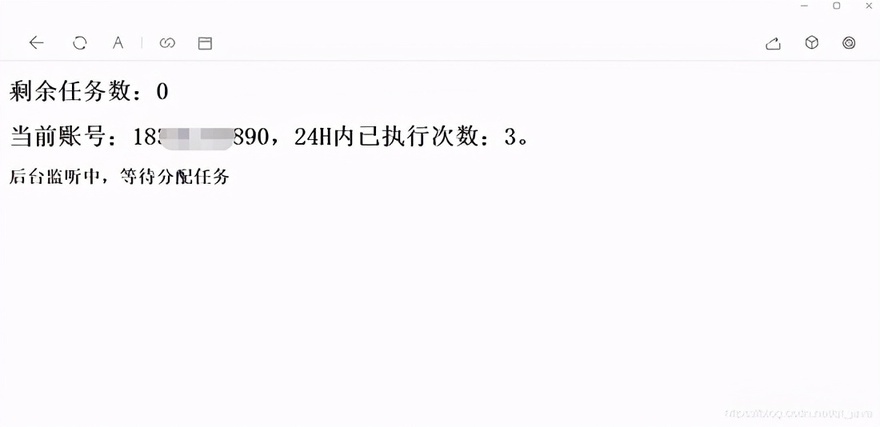

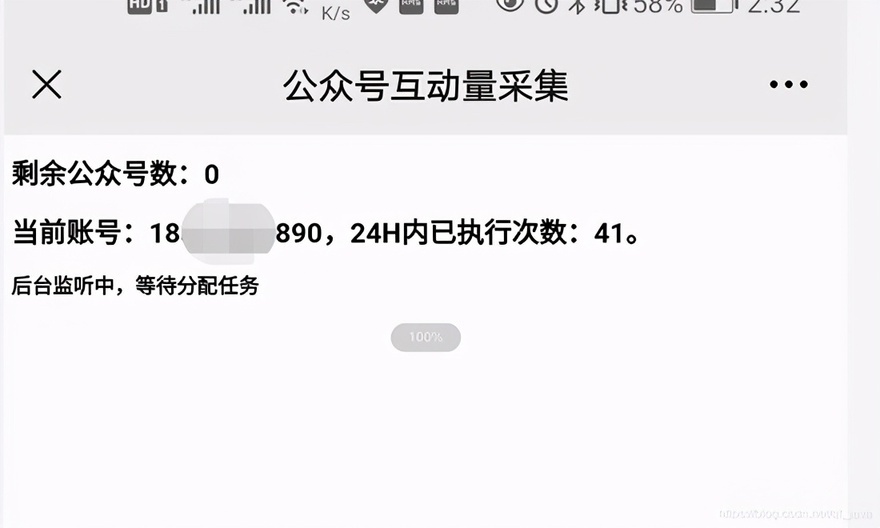

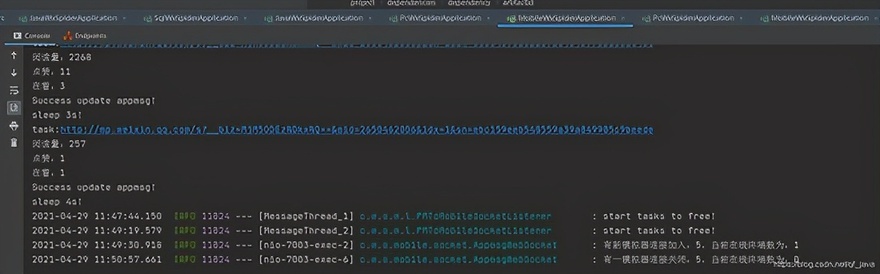

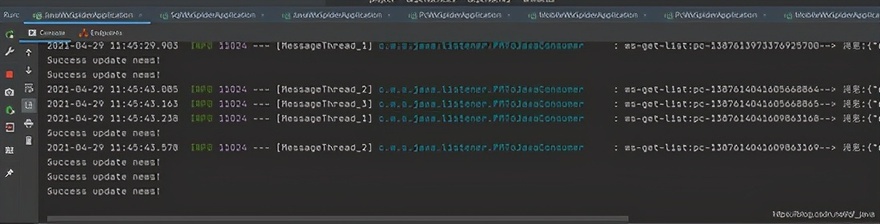

六、运行截图 PC 和手机

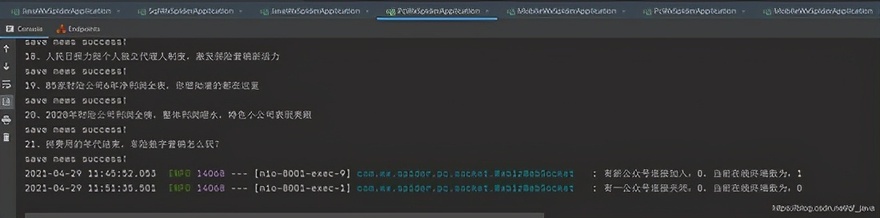

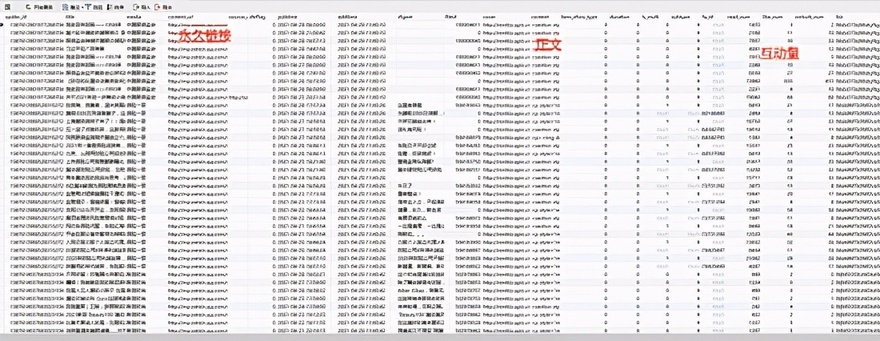

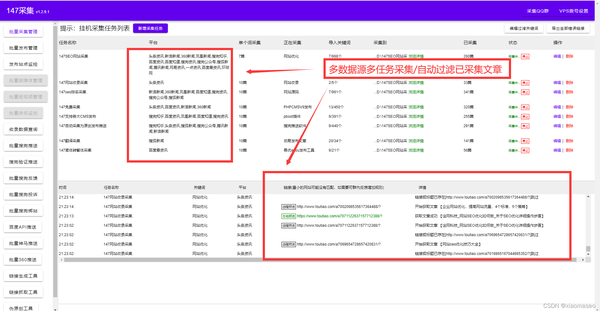

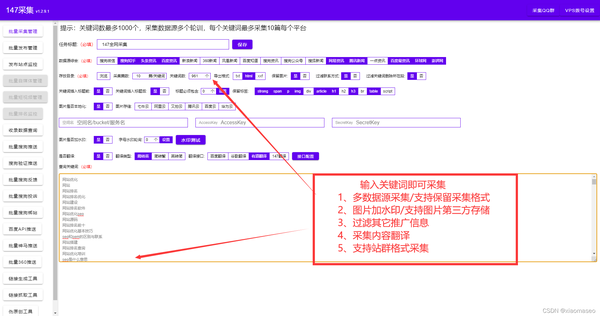

安慰

运行结束

总结

项目的亲测可用性现已上线,在项目开发中解决了微信搜狗临时链接到永久链接的问题,希望能帮助被类似业务困扰的老铁们。现在做java就像是逆水行舟。不进则退。我不知道你什么时候会参与进来。我希望每个人都有自己的向日葵采集。你不给这个采集吗?

原文链接:

如果你觉得这篇文章对你有帮助,可以转发、关注、支持 查看全部

文章采集完(spring使用springcloud架构来做爬虫,历时二十多天,终于搞定)

前言

因公司业务需要,需要获取客户提供的微信公众号历史文章,并每天更新。很明显,每天人工检查300多个公众号是不行的,把问题提交给IT团队。对于那些喜欢爬虫的人,我一定会尝试他。之前做过搜狗的微信爬虫,后来一直在做java web。这个项目重新点燃了我对爬虫的热爱。第一次使用spring cloud架构做爬虫。20多天后,终于搞定了。接下来我将通过一系列文章分享这个项目的经验,并提供源码供大家指正!

一、系统介绍

本系统是基于Java开发的。只需简单配置公众号名称或微信号,即可定时或实时抓取微信公众号的文章(包括阅读次数、点赞次数、观看次数)。

二、系统架构技术架构

Spring Cloud、Spring Boot、Mybatis-Plus、Nacos、RocketMq、nginx

贮存

Mysql、MongoDB、Redis、Solr

缓存

雷迪斯

演戏

提琴手

三、系统优缺点系统优势

1、配置公众号后,可以通过Fiddler的JS注入功能和Websocket实现自动爬取;2、系统为分布式架构,高可用;3、RocketMq 消息队列用于解耦合,可以解决采集由于网络抖动导致的失败。如果3次消费不成功,日志会记录到mysql,保证文章的完整性;4、可以加入任意数量的微信号提高采集效率,抵抗反爬限制;5、Redis缓存每条微信24小时内的采集记录,防止被封号;6、Nacos作为一个配置中心,可以通过热配置访问实时调整采集的频率;7、将数据采集存储到Solr集群,提高检索速度;8、将抓包返回的记录保存到MongoDB,方便存档查看错误日志。

系统缺点:

1、通过真机真实账号采集消息,如果需要采集大量公众号,需要有多个微信账号作为支持(如果账号达到上限当天,可以通过爬虫界面爬取微信公众平台获取新闻);2、不是公众号一发就可以马上抢到消息,采集时间是系统设置的,消息有一定的延迟(如果没有公众号多,微信数量足够。通过增加采集频率进行优化)。

四、模块介绍

由于后面会添加管理系统和API调用功能,所以提前封装了一些功能。

common-ws-starter

公共模块:存储工具类、实体类等公共消息。

redis-ws-starter

Redis模块:spring-boot-starter-data-redis的二次封装,暴露了封装后的Redis工具类和Redisson工具类。

火箭MQ-WS-启动器

RocketMq模块:rocketmq-spring-boot-starter的二次封装,提供消费重试和失败日志记录功能。

db-ws-starter

mysql数据源模块:封装mysql数据源,支持多数据源,通过自定义注解实现数据源的动态切换。

sql-wx-蜘蛛

mysql数据库模块:提供mysql数据库操作的所有功能。

pc-wx-蜘蛛

PC端采集模块:收录PC端采集公众号历史消息相关功能。

java-wx-蜘蛛

Java抽取模块:收录java程序抽取文章内容相关的功能。

移动 wx 蜘蛛

模拟器采集模块:收录通过模拟器或移动端采集消息交互量相关的功能。

五、一般流程图

六、运行截图 PC 和手机

安慰

运行结束

总结

项目的亲测可用性现已上线,在项目开发中解决了微信搜狗临时链接到永久链接的问题,希望能帮助被类似业务困扰的老铁们。现在做java就像是逆水行舟。不进则退。我不知道你什么时候会参与进来。我希望每个人都有自己的向日葵采集。你不给这个采集吗?

原文链接:

如果你觉得这篇文章对你有帮助,可以转发、关注、支持

文章采集完(释放双眼,带上耳机,听听看~!(本文目录))

采集交流 • 优采云 发表了文章 • 0 个评论 • 171 次浏览 • 2022-04-15 20:27

放开眼睛,戴上耳机,听~!

本文内容

本文介绍国家统计局于2019-01-31发布的《2018年统计区划代码和城乡区划代码(截至2018年10月31日)》的采集。

对比采集2016和2017版本使用的js代码,已经做了很大的优化和调整,我将打开文章来介绍这个V2版本。旧版本 文章。

19-03-22 2018年新采集城市数据

资料下载GitHub:

数据预览

数据源

国家统计局《2018年统计区划代码和城乡区划代码(截至2018年10月31日)》统计标准为撰写本文时的最新版本。

数据采集

对于data采集,根据工作需要,一些小的data采集函数有一些联系。因为对html和js比较熟悉,所以用IE浏览器支持本地html文件任意跨域ajax请求数据,并且支持读写Excel文件,所以直接写了一个html文件作为采集工具供他人使用,批量查询人员信息、检测结果等功能。所以采集js主要用于省市数据。

由于新版chrome有编码问题,统计局使用的是gb2312,会造成乱码。chrome 41的古董版没有问题,所以采集都是在chrome41下完成的。我自己做了一个便携版的Chrome,实现了多个版本的共存。

1. 抓取原创数据

涉及源码:1_国家统计局抓取城市信息.js

进入统计局页面,执行代码完成抓包,打开4个模拟线程,抓包省、市、镇4级数据还是很快的,采集3400+页,第一次跑1个左右分钟 花了几分钟才完成 采集 (我的截图是打开浏览器缓存的,所以有4秒的错觉。写这篇文章的时候,一个url被挂了,我没有'不知道统计局服务器是否有问题)。

采集完成后,会自动弹出保存的文件数据。

2. 拼音转换

这就需要找个接口把文字转成拼音。要求只有一个:重庆可以正常翻译成重庆,翻译成中青低。如果满足这个条件,百度上搜索到的99%的翻译网站都会被淘汰。

另外,Github 上很多高星级开源库的转换性能并不理想。我尝试了hotoo/pinyin并打开了分词。复音词的成绩差不了多少,所以放弃了。最后使用hankcs/HanLP的python库进行转换。地名中对复音词的支持仍然有限。很多地名都转换成斗囧,但都是同类型中最好的。

之前找到的翻译界面对拼音的转换准确率最高。据说是根据《新华词典》、《现代汉语词典》等规范词典校对的。不过,这个站从去年开始就对IP进行了限制。它曾经是随便转换的。从2017版数据采集开始,一直被克制。整个翻译过程接口调用不超过10次,中间可能需要改1-3次。代理(已实现用js自动切换代理)。

转换过程

因为这个采集的数据量比较大,省市级的数据只有3400条,而镇级的数据却有2万多条。转换压力有点大。所以省级和市级使用qqxuizi的高精度接口,镇级使用本地HanLP转换接口。另外,使用全名进行转换,比以前使用缩写短名和多音字更准确。

使用 HanLP 库进行本地转换,准确率低

涉及源代码:2_1_ Grab Pinyin.js

首先打开拼音转换python服务,服务程序在Github.pinyin-python-server目录下,按照介绍运行。

然后执行刚才抓取的页面中的js代码。当我写手稿时,我又跑了一遍。用了 4 个模拟线程和 5 分钟,完成了所有 4.70,000 条数据的传输。

为什么不用python直接传输,还得通过http请求呢?答:不会写,方便使用其他机器提供的接口,不用在本地搭建服务(我临时搭建了一个拼音接口测试服务器,可以测试)。

使用qqxiuzi重新转换省市3级,准确率高

涉及源代码:2_2_ Grab Pinyin.js

运行代码,然后根据提示导入上一步保存的数据,然后再次运行代码。如果IP被封,需要手动切换代理,或者根据源码中的提示设置SwitchyOmega自动切换代理。

整个转换过程大约需要1分钟,如果找到有效代理的速度较慢,可能需要更长的时间。(缓存拼音结果源代码中部分代码错误,等待下次采集修复,写稿时找到)

3. 处理数据并导出 CSV

涉及的源代码:3_format.js

处理数据相对简单,但由于对数据的分析,花费的时间最多。此外,新增港澳台4个海外数据。此外,去掉民族自治区、州、县、旗的后缀;民族乡镇。还有几个后缀被去掉的,城市|县|乡|镇|街道|街道办事处|地区办事处|社区服务中心,少一些的后缀没有去掉,有些地名可能有歧义。

代码运行后会自动弹出保存csv文件数据。

终于 查看全部

文章采集完(释放双眼,带上耳机,听听看~!(本文目录))

放开眼睛,戴上耳机,听~!

本文内容

本文介绍国家统计局于2019-01-31发布的《2018年统计区划代码和城乡区划代码(截至2018年10月31日)》的采集。

对比采集2016和2017版本使用的js代码,已经做了很大的优化和调整,我将打开文章来介绍这个V2版本。旧版本 文章。

19-03-22 2018年新采集城市数据

资料下载GitHub:

数据预览

数据源

国家统计局《2018年统计区划代码和城乡区划代码(截至2018年10月31日)》统计标准为撰写本文时的最新版本。

数据采集

对于data采集,根据工作需要,一些小的data采集函数有一些联系。因为对html和js比较熟悉,所以用IE浏览器支持本地html文件任意跨域ajax请求数据,并且支持读写Excel文件,所以直接写了一个html文件作为采集工具供他人使用,批量查询人员信息、检测结果等功能。所以采集js主要用于省市数据。

由于新版chrome有编码问题,统计局使用的是gb2312,会造成乱码。chrome 41的古董版没有问题,所以采集都是在chrome41下完成的。我自己做了一个便携版的Chrome,实现了多个版本的共存。

1. 抓取原创数据

涉及源码:1_国家统计局抓取城市信息.js

进入统计局页面,执行代码完成抓包,打开4个模拟线程,抓包省、市、镇4级数据还是很快的,采集3400+页,第一次跑1个左右分钟 花了几分钟才完成 采集 (我的截图是打开浏览器缓存的,所以有4秒的错觉。写这篇文章的时候,一个url被挂了,我没有'不知道统计局服务器是否有问题)。

采集完成后,会自动弹出保存的文件数据。

2. 拼音转换

这就需要找个接口把文字转成拼音。要求只有一个:重庆可以正常翻译成重庆,翻译成中青低。如果满足这个条件,百度上搜索到的99%的翻译网站都会被淘汰。

另外,Github 上很多高星级开源库的转换性能并不理想。我尝试了hotoo/pinyin并打开了分词。复音词的成绩差不了多少,所以放弃了。最后使用hankcs/HanLP的python库进行转换。地名中对复音词的支持仍然有限。很多地名都转换成斗囧,但都是同类型中最好的。

之前找到的翻译界面对拼音的转换准确率最高。据说是根据《新华词典》、《现代汉语词典》等规范词典校对的。不过,这个站从去年开始就对IP进行了限制。它曾经是随便转换的。从2017版数据采集开始,一直被克制。整个翻译过程接口调用不超过10次,中间可能需要改1-3次。代理(已实现用js自动切换代理)。

转换过程

因为这个采集的数据量比较大,省市级的数据只有3400条,而镇级的数据却有2万多条。转换压力有点大。所以省级和市级使用qqxuizi的高精度接口,镇级使用本地HanLP转换接口。另外,使用全名进行转换,比以前使用缩写短名和多音字更准确。

使用 HanLP 库进行本地转换,准确率低

涉及源代码:2_1_ Grab Pinyin.js

首先打开拼音转换python服务,服务程序在Github.pinyin-python-server目录下,按照介绍运行。

然后执行刚才抓取的页面中的js代码。当我写手稿时,我又跑了一遍。用了 4 个模拟线程和 5 分钟,完成了所有 4.70,000 条数据的传输。

为什么不用python直接传输,还得通过http请求呢?答:不会写,方便使用其他机器提供的接口,不用在本地搭建服务(我临时搭建了一个拼音接口测试服务器,可以测试)。

使用qqxiuzi重新转换省市3级,准确率高

涉及源代码:2_2_ Grab Pinyin.js

运行代码,然后根据提示导入上一步保存的数据,然后再次运行代码。如果IP被封,需要手动切换代理,或者根据源码中的提示设置SwitchyOmega自动切换代理。

整个转换过程大约需要1分钟,如果找到有效代理的速度较慢,可能需要更长的时间。(缓存拼音结果源代码中部分代码错误,等待下次采集修复,写稿时找到)

3. 处理数据并导出 CSV

涉及的源代码:3_format.js

处理数据相对简单,但由于对数据的分析,花费的时间最多。此外,新增港澳台4个海外数据。此外,去掉民族自治区、州、县、旗的后缀;民族乡镇。还有几个后缀被去掉的,城市|县|乡|镇|街道|街道办事处|地区办事处|社区服务中心,少一些的后缀没有去掉,有些地名可能有歧义。

代码运行后会自动弹出保存csv文件数据。

终于

文章采集完(帝国CMS采集插件增加一个新的采集规则点击增加节点按钮)

采集交流 • 优采云 发表了文章 • 0 个评论 • 101 次浏览 • 2022-04-15 11:34

Empirecms采集其实很简单,使用Empirecms采集插件即可。这是 7.0 的示例

进入Empirecms后台,选择“Columns”菜单,在左侧菜单中选择“采集Management”

打开管理采集节点

可以看到所有现有的 采集 规则节点

让我们开始添加一个新的 采集 规则

单击添加节点按钮

中间提示选择要创建的栏目点击你要创建的栏目,比如国际新闻。嗯,点进去。出现的界面有第一个节点的名字,因为上面创建了国际新闻,填国际新闻父节点不用管(就是留空)

页面地址采集,一般选择新闻列表页面,可以在新浪国际新闻中复制,比如国际新闻的地址,在地址栏复制即可。

采集页面地址方式2无需填写内容,页面地址前缀写为

图片/FLASH地址前缀(内容)~~~ 截取内容的介绍不用开始填写采集内容是正规的。这时候就需要看网页的源码了。

常规页面链接

标题图像是常规的,标题不是必需的。打开内容页面,打开刚才制作的大栏目中的文章。

正则副标题:~~~信息来源正则不写新闻正文正则:

好的提交!

看看有没有错误

点击“预览”采集进入节点预览结果:

采集内容页面列表

采集内容页面页面:

预览采集节点无误后,返回“管理节点”,点击“开始采集”链接启动进程采集

系统是 采集

采集完成后会显示本地暂存信息。此时可以修改或删除暂存信息。

查看采集的信息并放入仓库,点击仓库中所有信息的按钮

确定行动

信息存储完成提醒

信息存入数据库后,点击管理信息

我们可以看到新闻信息只是采集

至此,采集资料全部完成,帝国cms采集很强大,需要自己去探索。

注意:

一般采集小于2种情况:

1、列表页选择的采集区域不正确

2、详情页常规错误

可以通过逐项预览找到原因,基本上可以采集,包括伪静态。 查看全部

文章采集完(帝国CMS采集插件增加一个新的采集规则点击增加节点按钮)

Empirecms采集其实很简单,使用Empirecms采集插件即可。这是 7.0 的示例

进入Empirecms后台,选择“Columns”菜单,在左侧菜单中选择“采集Management”

打开管理采集节点

可以看到所有现有的 采集 规则节点

让我们开始添加一个新的 采集 规则

单击添加节点按钮

中间提示选择要创建的栏目点击你要创建的栏目,比如国际新闻。嗯,点进去。出现的界面有第一个节点的名字,因为上面创建了国际新闻,填国际新闻父节点不用管(就是留空)

页面地址采集,一般选择新闻列表页面,可以在新浪国际新闻中复制,比如国际新闻的地址,在地址栏复制即可。

采集页面地址方式2无需填写内容,页面地址前缀写为

图片/FLASH地址前缀(内容)~~~ 截取内容的介绍不用开始填写采集内容是正规的。这时候就需要看网页的源码了。

常规页面链接

标题图像是常规的,标题不是必需的。打开内容页面,打开刚才制作的大栏目中的文章。

正则副标题:~~~信息来源正则不写新闻正文正则:

好的提交!

看看有没有错误

点击“预览”采集进入节点预览结果:

采集内容页面列表

采集内容页面页面:

预览采集节点无误后,返回“管理节点”,点击“开始采集”链接启动进程采集

系统是 采集

采集完成后会显示本地暂存信息。此时可以修改或删除暂存信息。

查看采集的信息并放入仓库,点击仓库中所有信息的按钮

确定行动

信息存储完成提醒

信息存入数据库后,点击管理信息

我们可以看到新闻信息只是采集

至此,采集资料全部完成,帝国cms采集很强大,需要自己去探索。

注意:

一般采集小于2种情况:

1、列表页选择的采集区域不正确

2、详情页常规错误

可以通过逐项预览找到原因,基本上可以采集,包括伪静态。

文章采集完(简单的介绍了JAVA通过代码如何使用MDC进行日志打印)

采集交流 • 优采云 发表了文章 • 0 个评论 • 130 次浏览 • 2022-04-15 11:28

我是目录kibana操作总结

审查

前两篇文章通过代码简单介绍了JAVA如何使用MDC打印日志,查看log4j MDC用户操作日志跟踪配置,以及ELK平台搭建,查看log4j MDC用户操作日志跟踪配置. 接下来结合实际案例,简单介绍一下生产服务器的日志是如何通过logstash进行采集统一聚合的,这样我们就可以快速、方便、高效的查询日志,并且可以轻松定位哪个日志是日志。服务器生成,不再需要一味地翻遍所有生产服务器,只为找到问题所在。

logstash 日志采集

因为我们打印各种日志,为了方便我们通过kibana进行检索,需要在logstash中配置相应的采集规则。如果你什么都不做,只是简单地采集,可能会出现一些意想不到的事情。错误。

日志采集按行采集。当您的日志换行时,换行的行被视为单独的行,因此日志 采集 非常可读。如果使用MDC,配置log4j日志格式输出,如果不符合规则,则整行采集到message字段。这个时候,基本不可能按照某个领域快速搜索。

基于以上可能出现的“错误”,我们需要针对当前项目的日志配置文件制定自己的采集规则。

其实logstash的配置文件很简单,基本上就是下面几个套路,日志源从哪里来(input输入插件),什么样的规则(filter过滤插件),日志输出在哪里finally(输出输出插件)

# 输入

input {

...

}

# 过滤器

filter {

...

}

# 输出

output {

...

}

因为我们这里介绍的是项目日志的采集,输入当然是来自file文件,配置如下:

input {

file {

type => "wechat-log"

path => ["/usr/local/tomcat/logs/wechat/*.log"]

codec => multiline{

pattern => "^\[%{TIMESTAMP_ISO8601}\]"

what => "previous"

negate => true

}

start_position => "beginning"

}

}

其中path是日志采集所在的地方,从日志文件采集的第一行开始,定义一个类型(通常是kibana结尾的索引)。

编解码器插件

这里codec的存在可以解决我们前面提到的log wrapping等问题。在logstash读入时,日志通过codec编码解析成对应的格式,从logstash输出时,通过codec解码成对应的格式。当我们的应用打印出带有换行符的日志时,比如ERROR日志,一般都有错误堆栈信息,各种以at开头的行,我们可以通过多行处理,让logstash认为这一行属于上一行,而不是将其视为新行。

一般我们的tomcat日志都是以时间开头的,没有像at这样的堆栈信息的时间,所以我们可以配置正则表达式[^[%{TIMESTAMP_ISO8601}]],只有当日志以时间开头的一行才换行. 如果不是时间的开始,则属于前一个[what=>previous]或后一个[what=>next]。这里我们将其配置为属于上一个。

上面的配置解决了换行问题之后,接下来我们还需要按照字段来处理日志切分。

grok 插件

在grok中,可以通过正则表达式提取日志信息。正则表达式有两种,一种是内置正则表达式,另一种是自定义正则表达式。当内置的正则表达式不能满足我们的需求时,我们不得不使用自定义的正则表达式,但是内置的基本满足我们的需求。详情见grok介绍

假设我们的日志配置文件是这样配置的:

我们设置了商家、openid、queryType、orderId、wechatOrderId、input、source 7个字段,生产服务器打印的日志格式如下:

[2019-01-27 17:51:22.051] - iPhoneBaoXiu - oisb3smtzToo7jNA4abazKktnECQ - senior - aa4820190127175110 - 4200000283201901277968491434 - 352982093855677 - 1 - INFO com.apple.wechat.service.Worker:401 - 发送模板消息,查询结果为:me.chanjar.weixin.mp.bean.template.WxMpTemplateData@3813022d

[2019-01-27 17:51:22.230] - iPhoneBaoXiu - oisb3smtzToo7jNA4abazKktnECQ - senior - aa4820190127175110 - 42000002832019277968491434 - 352982093855677 - 1 - ERROR me.chanjar.weixin.mp.api.impl.WxMpServiceImpl:403 -

[URL]: https://api.weixin.qq.com/cgi- ... /send

[PARAMS]: {"touser":"olC5FwLnXjtCbQsW76lkevV57nH0","template_id":"Qt1zyzQs4R1uPrJylGQLSUTS6QcG6UyWB2zDzGt7QGY","url":"http://mp.weixin.qq.com/bizmal ... ot%3B,"data":{"first":{"value":"查询结果","color":"#B452CD"},"keyword1":{"value":"aa4820190127175110","color":"#FF4040"},"keyword2":{"value":"352982093855677","color":"#FF4040"},"keyword3":{"value":"1.00元","color":"#FF4040"},"remark":********************}

[RESPONSE]: {"errcode":40003,"errmsg":"invalid openid hint: [mLJNpa06824120]"}

[2019-01-27 17:51:22.230] - iPhoneBaoXiu - oisb3smtzToo7jNA4abazKktnECQ - senior - aa4820190127175110 - 4200000283201901277968491434 - 352982093855677 - 1 - ERROR com.apple.wechat.service.Worker:405 - 发送模板消息失败,{"errcode":40003,"errmsg":"invalid openid hint: [mLJNpa06824120]"}

[2019-01-27 17:51:22.231] - iPhoneBaoXiu - oisb3smtzToo7jNA4abazKktnECQ - senior - aa4820190127175110 - 4200000283201901277968491434 - 352982093855677 - 1 - INFO com.apple.wechat.service.RefundService:57 - 开始发起退款,退款订单id:2056653,微信订单号:4200000283201901277968491434

[2019-01-27 17:51:22.463] - - - - - - - - INFO com.apple.wechat.service.Worker:94 - 执行任务:QueryTask{msg='C39XQ4NFKPGN', fromUserId='oOEvtjsGdmAKrZx81zsACqBjjdsA', merchant='MLdress', type='senior', authUserId='olC5FwH40UpZakKBZRls_t_HR9Ew', price='1.00', tradeNo='e50b20190127175115', model='', orderId=2056654, needRefund=false, needRedo=false, sendMsg=false, msgType='1', lat='', lon='', token='e50ba187b2f84297b60fc14699748679', wechatOrderNo='4200000269201901277039023012'}

[2019-01-27 17:51:23.327] - iPhoneBaoXiu - oisb3smtzToo7jNA4abazKktnECQ - senior - aa4820190127175110 - 4200000283201901277968491434 - 352982093855677 - 1 - INFO com.apple.wechat.service.RefundService:97 - 退款结果:success, 实付金额:1.00,发起退款金额:1.00

[2019-01-27 17:51:26.876] - - - - - - - - INFO com.apple.wechat.service.Worker:94 - 执行任务:QueryTask{msg='C39T81JEHG01', fromUserId='oOEvtjotDEF8doO3xVxyJ0-dCqFM', merchant='MLdress', type='normal', authUserId='', price='', tradeNo='', model='', orderId=0, needRefund=false, needRedo=false, sendMsg=false, msgType='1', lat='', lon='', token='', wechatOrderNo=''}

[2019-01-27 17:51:28.003] - MLdress - oOEvtjsGdmAKrZx81zsACqBjjdsA - senior - e50b20190127175115 - 4200000269201901277039023012 - C39XQ4NFKPGN - 1 - INFO com.apple.wechat.util.HttpUtils:125 - http execute cost total seconds 5540

我们可以使用下面的正则表达式对日志进行切分,将内容赋值给对应的字段

filter {

grok {

match => ["message", "\[%{TIMESTAMP_ISO8601:logdate}\] - (?[\b\w\s]*) - (?[\u4e00-\u9fa5\b\w\s]*) - (?[\b\w\s]*) - (?[\b\w\s]*) - (?[\b\w\s]*) - (?[\b\w\s]*) - (?[\b\w\s]*) - %{WORD:level}\s*%{JAVACLASS:class}:%{NUMBER:lineNumber} - (?[\W\w\S\s]*)"]

}

date {

match => ["logdate", "yyyy-MM-dd HH:mm:ss.SSS"]

target => "@timestamp"

}

}

(?[\b\w\s]*) 表示使用[]中的正则表达式,将识别结果放入商家字段中,其他类似。至于这里的match怎么写,和你的log配置文件和你想要的效果有很大关系,所以只能慢慢调试,直到你写的match能正确切出你的log文件。在线测试你的正则表达式是否能匹配项目输出日志测试工具传送门

完整的配置文件

input {

file {

type => "wechat-log"

path => ["/usr/local/tomcat/logs/wechat/*.log"]

codec => multiline{

pattern => "^\[%{TIMESTAMP_ISO8601}\]"

what => "previous"

negate => true

}

start_position => "beginning"

}

}

filter {

grok {

match => ["message", "\[%{TIMESTAMP_ISO8601:logdate}\] - (?[\b\w\s]*) - (?[\u4e00-\u9fa5\b\w\s]*) - (?[\b\w\s]*) - (?[\b\w\s]*) - (?[\b\w\s]*) - (?[\b\w\s]*) - (?[\b\w\s]*) - %{WORD:level}\s*%{JAVACLASS:class}:%{NUMBER:lineNumber} - (?[\W\w\S\s]*)"]

}

date {

match => ["logdate", "yyyy-MM-dd HH:mm:ss.SSS"]

target => "@timestamp"

}

}

output {

elasticsearch {

hosts => "**************:9200"

index => "logstash-%{type}"

template_overwrite => true

}

}

保存后,启动logstash。命令:

nohup ./bin/logstash agent -f config/log.conf &

kibana操作首先是创建索引,因为我们的输出配置了logstash-%{type}的索引,所以索引为:logstash-wechat-log 创建索引后可以发现kibana列出了我们的字段前面定义过,如下图。

接下来,我们可以通过各种条件搜索日志。

假设我们要搜索商家为MLdress,用户输入内容为3565的日志信息,那么只需输入[merchant:MLdress AND input:3565]即可搜索对应的日志,如下图所示。

总结

通过在代码中使用MDC进行标准的日志打印,结合logstash提供的强大的日志采集插件,为了解决日志换行和我们自定义字段的问题,我们需要配置logstash配置文件来报告将所有服务器的日志统一到es,通过kibana进行自查询操作。只有这样,才能大大提高日常的开发效率。

程序员除了能写代码外,还必须具备快速发现和定位问题的能力。如果没有 ELK 这样的工具,其实是比较难快速查找和定位的。

所以,你知道的,现在就使用它。 查看全部

文章采集完(简单的介绍了JAVA通过代码如何使用MDC进行日志打印)

我是目录kibana操作总结

审查

前两篇文章通过代码简单介绍了JAVA如何使用MDC打印日志,查看log4j MDC用户操作日志跟踪配置,以及ELK平台搭建,查看log4j MDC用户操作日志跟踪配置. 接下来结合实际案例,简单介绍一下生产服务器的日志是如何通过logstash进行采集统一聚合的,这样我们就可以快速、方便、高效的查询日志,并且可以轻松定位哪个日志是日志。服务器生成,不再需要一味地翻遍所有生产服务器,只为找到问题所在。

logstash 日志采集

因为我们打印各种日志,为了方便我们通过kibana进行检索,需要在logstash中配置相应的采集规则。如果你什么都不做,只是简单地采集,可能会出现一些意想不到的事情。错误。

日志采集按行采集。当您的日志换行时,换行的行被视为单独的行,因此日志 采集 非常可读。如果使用MDC,配置log4j日志格式输出,如果不符合规则,则整行采集到message字段。这个时候,基本不可能按照某个领域快速搜索。

基于以上可能出现的“错误”,我们需要针对当前项目的日志配置文件制定自己的采集规则。

其实logstash的配置文件很简单,基本上就是下面几个套路,日志源从哪里来(input输入插件),什么样的规则(filter过滤插件),日志输出在哪里finally(输出输出插件)

# 输入

input {

...

}

# 过滤器

filter {

...

}

# 输出

output {

...

}

因为我们这里介绍的是项目日志的采集,输入当然是来自file文件,配置如下:

input {

file {

type => "wechat-log"

path => ["/usr/local/tomcat/logs/wechat/*.log"]

codec => multiline{

pattern => "^\[%{TIMESTAMP_ISO8601}\]"

what => "previous"

negate => true

}

start_position => "beginning"

}

}

其中path是日志采集所在的地方,从日志文件采集的第一行开始,定义一个类型(通常是kibana结尾的索引)。

编解码器插件

这里codec的存在可以解决我们前面提到的log wrapping等问题。在logstash读入时,日志通过codec编码解析成对应的格式,从logstash输出时,通过codec解码成对应的格式。当我们的应用打印出带有换行符的日志时,比如ERROR日志,一般都有错误堆栈信息,各种以at开头的行,我们可以通过多行处理,让logstash认为这一行属于上一行,而不是将其视为新行。

一般我们的tomcat日志都是以时间开头的,没有像at这样的堆栈信息的时间,所以我们可以配置正则表达式[^[%{TIMESTAMP_ISO8601}]],只有当日志以时间开头的一行才换行. 如果不是时间的开始,则属于前一个[what=>previous]或后一个[what=>next]。这里我们将其配置为属于上一个。

上面的配置解决了换行问题之后,接下来我们还需要按照字段来处理日志切分。

grok 插件

在grok中,可以通过正则表达式提取日志信息。正则表达式有两种,一种是内置正则表达式,另一种是自定义正则表达式。当内置的正则表达式不能满足我们的需求时,我们不得不使用自定义的正则表达式,但是内置的基本满足我们的需求。详情见grok介绍

假设我们的日志配置文件是这样配置的:

我们设置了商家、openid、queryType、orderId、wechatOrderId、input、source 7个字段,生产服务器打印的日志格式如下:

[2019-01-27 17:51:22.051] - iPhoneBaoXiu - oisb3smtzToo7jNA4abazKktnECQ - senior - aa4820190127175110 - 4200000283201901277968491434 - 352982093855677 - 1 - INFO com.apple.wechat.service.Worker:401 - 发送模板消息,查询结果为:me.chanjar.weixin.mp.bean.template.WxMpTemplateData@3813022d

[2019-01-27 17:51:22.230] - iPhoneBaoXiu - oisb3smtzToo7jNA4abazKktnECQ - senior - aa4820190127175110 - 42000002832019277968491434 - 352982093855677 - 1 - ERROR me.chanjar.weixin.mp.api.impl.WxMpServiceImpl:403 -

[URL]: https://api.weixin.qq.com/cgi- ... /send

[PARAMS]: {"touser":"olC5FwLnXjtCbQsW76lkevV57nH0","template_id":"Qt1zyzQs4R1uPrJylGQLSUTS6QcG6UyWB2zDzGt7QGY","url":"http://mp.weixin.qq.com/bizmal ... ot%3B,"data":{"first":{"value":"查询结果","color":"#B452CD"},"keyword1":{"value":"aa4820190127175110","color":"#FF4040"},"keyword2":{"value":"352982093855677","color":"#FF4040"},"keyword3":{"value":"1.00元","color":"#FF4040"},"remark":********************}

[RESPONSE]: {"errcode":40003,"errmsg":"invalid openid hint: [mLJNpa06824120]"}

[2019-01-27 17:51:22.230] - iPhoneBaoXiu - oisb3smtzToo7jNA4abazKktnECQ - senior - aa4820190127175110 - 4200000283201901277968491434 - 352982093855677 - 1 - ERROR com.apple.wechat.service.Worker:405 - 发送模板消息失败,{"errcode":40003,"errmsg":"invalid openid hint: [mLJNpa06824120]"}

[2019-01-27 17:51:22.231] - iPhoneBaoXiu - oisb3smtzToo7jNA4abazKktnECQ - senior - aa4820190127175110 - 4200000283201901277968491434 - 352982093855677 - 1 - INFO com.apple.wechat.service.RefundService:57 - 开始发起退款,退款订单id:2056653,微信订单号:4200000283201901277968491434

[2019-01-27 17:51:22.463] - - - - - - - - INFO com.apple.wechat.service.Worker:94 - 执行任务:QueryTask{msg='C39XQ4NFKPGN', fromUserId='oOEvtjsGdmAKrZx81zsACqBjjdsA', merchant='MLdress', type='senior', authUserId='olC5FwH40UpZakKBZRls_t_HR9Ew', price='1.00', tradeNo='e50b20190127175115', model='', orderId=2056654, needRefund=false, needRedo=false, sendMsg=false, msgType='1', lat='', lon='', token='e50ba187b2f84297b60fc14699748679', wechatOrderNo='4200000269201901277039023012'}

[2019-01-27 17:51:23.327] - iPhoneBaoXiu - oisb3smtzToo7jNA4abazKktnECQ - senior - aa4820190127175110 - 4200000283201901277968491434 - 352982093855677 - 1 - INFO com.apple.wechat.service.RefundService:97 - 退款结果:success, 实付金额:1.00,发起退款金额:1.00

[2019-01-27 17:51:26.876] - - - - - - - - INFO com.apple.wechat.service.Worker:94 - 执行任务:QueryTask{msg='C39T81JEHG01', fromUserId='oOEvtjotDEF8doO3xVxyJ0-dCqFM', merchant='MLdress', type='normal', authUserId='', price='', tradeNo='', model='', orderId=0, needRefund=false, needRedo=false, sendMsg=false, msgType='1', lat='', lon='', token='', wechatOrderNo=''}

[2019-01-27 17:51:28.003] - MLdress - oOEvtjsGdmAKrZx81zsACqBjjdsA - senior - e50b20190127175115 - 4200000269201901277039023012 - C39XQ4NFKPGN - 1 - INFO com.apple.wechat.util.HttpUtils:125 - http execute cost total seconds 5540

我们可以使用下面的正则表达式对日志进行切分,将内容赋值给对应的字段

filter {

grok {

match => ["message", "\[%{TIMESTAMP_ISO8601:logdate}\] - (?[\b\w\s]*) - (?[\u4e00-\u9fa5\b\w\s]*) - (?[\b\w\s]*) - (?[\b\w\s]*) - (?[\b\w\s]*) - (?[\b\w\s]*) - (?[\b\w\s]*) - %{WORD:level}\s*%{JAVACLASS:class}:%{NUMBER:lineNumber} - (?[\W\w\S\s]*)"]

}

date {

match => ["logdate", "yyyy-MM-dd HH:mm:ss.SSS"]

target => "@timestamp"

}

}

(?[\b\w\s]*) 表示使用[]中的正则表达式,将识别结果放入商家字段中,其他类似。至于这里的match怎么写,和你的log配置文件和你想要的效果有很大关系,所以只能慢慢调试,直到你写的match能正确切出你的log文件。在线测试你的正则表达式是否能匹配项目输出日志测试工具传送门

完整的配置文件

input {

file {

type => "wechat-log"

path => ["/usr/local/tomcat/logs/wechat/*.log"]

codec => multiline{

pattern => "^\[%{TIMESTAMP_ISO8601}\]"

what => "previous"

negate => true

}

start_position => "beginning"

}

}

filter {

grok {

match => ["message", "\[%{TIMESTAMP_ISO8601:logdate}\] - (?[\b\w\s]*) - (?[\u4e00-\u9fa5\b\w\s]*) - (?[\b\w\s]*) - (?[\b\w\s]*) - (?[\b\w\s]*) - (?[\b\w\s]*) - (?[\b\w\s]*) - %{WORD:level}\s*%{JAVACLASS:class}:%{NUMBER:lineNumber} - (?[\W\w\S\s]*)"]

}

date {

match => ["logdate", "yyyy-MM-dd HH:mm:ss.SSS"]

target => "@timestamp"

}

}

output {

elasticsearch {

hosts => "**************:9200"

index => "logstash-%{type}"

template_overwrite => true

}

}

保存后,启动logstash。命令:

nohup ./bin/logstash agent -f config/log.conf &

kibana操作首先是创建索引,因为我们的输出配置了logstash-%{type}的索引,所以索引为:logstash-wechat-log 创建索引后可以发现kibana列出了我们的字段前面定义过,如下图。

接下来,我们可以通过各种条件搜索日志。

假设我们要搜索商家为MLdress,用户输入内容为3565的日志信息,那么只需输入[merchant:MLdress AND input:3565]即可搜索对应的日志,如下图所示。

总结

通过在代码中使用MDC进行标准的日志打印,结合logstash提供的强大的日志采集插件,为了解决日志换行和我们自定义字段的问题,我们需要配置logstash配置文件来报告将所有服务器的日志统一到es,通过kibana进行自查询操作。只有这样,才能大大提高日常的开发效率。

程序员除了能写代码外,还必须具备快速发现和定位问题的能力。如果没有 ELK 这样的工具,其实是比较难快速查找和定位的。

所以,你知道的,现在就使用它。

文章采集完(有时网页抓取是不够的吗?(一)_)

采集交流 • 优采云 发表了文章 • 0 个评论 • 110 次浏览 • 2022-04-13 01:15

微信公众号文章采集工具让我们获取大量优质素材,微信公众号会生成大量文章、图片内容等素材每天,通过数据采集借助处理工具,可以免费批量工业爆文采集公众号数据文章我们需要采集,保存在本地,进行数据分析或二次创建等

微信公众号文章采集工具操作简单,页面简单方便。我们只需要鼠标点击即可完成采集配置,然后启动目标URL采集。支持采集资源标签保留(更好的保存格式)、过滤原文中敏感词(去除电话号码、地址等)、去除原图水印等。

有时网页抓取还不够;通常需要更深入地挖掘和分析数据,以揭示数据背后的真正含义并发现有价值的见解。数据和内容的分析利用可以说与我们的工作生活息息相关。

以网站SEO为例,通过数据分析,我们可以统计出网站每天的流量变化和页面跳出率,得出我们在某些环节的网站不足之处。数据还可以用于采集分析竞争对手排名关键词与我们之间的差距,以便我们及时调整,做出更好的优化响应。

当然,如果你不喜欢使用工具,我们也可以自己打代码来完成这部分工作:

第一步是通过创建蜘蛛从目标中抓取内容:

为了保存数据,以 Facebook 为例,我们将定义一个收录三个字段的项目:“title”、“content”和“stars”:

importscrapy

classFacebookSentimentItem(scrapy.Item):

title=scrapy.Field()

content=scrapy.Field()

stars=scrapy.Field()

我们还创建了一个蜘蛛来填充这些项目。我们为页面提供的起始 URL。

importscrapy

来自Facebook_sentiment.itemsimportFacebookSentimentItem

类目标蜘蛛(scrapy.Spider):

name="目标"

start_urls=[域名]

然后我们定义一个函数来解析单个内容并保存其数据:

defparse_review(self,response):

item=FacebookSentimentItem()

item['title']=response.xpath('//div[@class="quote"]/text()').extract()[0][1:-1]#stripthequotes(firstandlastchar)

item['content']=response.xpath('//div[@class="entry"]/p/text()').extract()[0]

item['stars']=response.xpath('//span[@class="ratesprite-rating_srating_s"]/img/@alt').extract()[0]

退货

之后,我们定义一个函数来解析内容页面,然后传递页面。我们会注意到,在内容页面上,我们看不到整个内容,而只是开始。我们将通过单击指向完整内容的链接并使用 parse_review 从该页面抓取数据来解决此问题:

defparse_Facebook(self,response):

forhrefinresponse.xpath('//div[@class="quote"]/a/@href'):

url=response.urljoin(href.extract())

yieldscrapy.Request(url,callback=self.parse_review)

next_page=response.xpath('//div[@class="unifiedpagination"]/child::*[2][self::a]/@href')

ifnext_page:

url=response.urljoin(next_page[0].extract())

yieldscrapy.Request(url,self.parse_Facebook)

最后,我们定义主解析函数,它会从主页面开始,解析其所有内容:

defparse(self,response):

forhrefinresponse.xpath('//div[@class="listing_title"]/a/@href'):

url=response.urljoin(href.extract())

yieldscrapy.Request(url,callback=self.parse_Facebook)

next_page=response.xpath('//div[@class="unifiedpaginationstandard_pagination"]/child::*[2][self::a]/@href')

ifnext_page:

url=response.urljoin(next_page[0].extract())

yieldscrapy.Request(url,self.parse)

所以,对于内容:我们告诉蜘蛛从主页开始,点击每条内容的链接,然后抓取数据。完成每一页后,它会得到下一页,所以它可以抓取我们需要的尽可能多的内容。

可见,使用代码进行我们的微信公众号文章采集不仅复杂,还需要更多的专业知识。在网站优化方面,还是要坚持最优解。微信公众号文章采集的分享及处理到此结束。如有不同意见,请留言讨论。 查看全部

文章采集完(有时网页抓取是不够的吗?(一)_)

微信公众号文章采集工具让我们获取大量优质素材,微信公众号会生成大量文章、图片内容等素材每天,通过数据采集借助处理工具,可以免费批量工业爆文采集公众号数据文章我们需要采集,保存在本地,进行数据分析或二次创建等

微信公众号文章采集工具操作简单,页面简单方便。我们只需要鼠标点击即可完成采集配置,然后启动目标URL采集。支持采集资源标签保留(更好的保存格式)、过滤原文中敏感词(去除电话号码、地址等)、去除原图水印等。

有时网页抓取还不够;通常需要更深入地挖掘和分析数据,以揭示数据背后的真正含义并发现有价值的见解。数据和内容的分析利用可以说与我们的工作生活息息相关。

以网站SEO为例,通过数据分析,我们可以统计出网站每天的流量变化和页面跳出率,得出我们在某些环节的网站不足之处。数据还可以用于采集分析竞争对手排名关键词与我们之间的差距,以便我们及时调整,做出更好的优化响应。

当然,如果你不喜欢使用工具,我们也可以自己打代码来完成这部分工作:

第一步是通过创建蜘蛛从目标中抓取内容:

为了保存数据,以 Facebook 为例,我们将定义一个收录三个字段的项目:“title”、“content”和“stars”:

importscrapy

classFacebookSentimentItem(scrapy.Item):

title=scrapy.Field()

content=scrapy.Field()

stars=scrapy.Field()

我们还创建了一个蜘蛛来填充这些项目。我们为页面提供的起始 URL。

importscrapy

来自Facebook_sentiment.itemsimportFacebookSentimentItem

类目标蜘蛛(scrapy.Spider):

name="目标"

start_urls=[域名]

然后我们定义一个函数来解析单个内容并保存其数据:

defparse_review(self,response):

item=FacebookSentimentItem()

item['title']=response.xpath('//div[@class="quote"]/text()').extract()[0][1:-1]#stripthequotes(firstandlastchar)

item['content']=response.xpath('//div[@class="entry"]/p/text()').extract()[0]

item['stars']=response.xpath('//span[@class="ratesprite-rating_srating_s"]/img/@alt').extract()[0]

退货

之后,我们定义一个函数来解析内容页面,然后传递页面。我们会注意到,在内容页面上,我们看不到整个内容,而只是开始。我们将通过单击指向完整内容的链接并使用 parse_review 从该页面抓取数据来解决此问题:

defparse_Facebook(self,response):

forhrefinresponse.xpath('//div[@class="quote"]/a/@href'):

url=response.urljoin(href.extract())

yieldscrapy.Request(url,callback=self.parse_review)

next_page=response.xpath('//div[@class="unifiedpagination"]/child::*[2][self::a]/@href')

ifnext_page:

url=response.urljoin(next_page[0].extract())

yieldscrapy.Request(url,self.parse_Facebook)

最后,我们定义主解析函数,它会从主页面开始,解析其所有内容:

defparse(self,response):

forhrefinresponse.xpath('//div[@class="listing_title"]/a/@href'):

url=response.urljoin(href.extract())

yieldscrapy.Request(url,callback=self.parse_Facebook)

next_page=response.xpath('//div[@class="unifiedpaginationstandard_pagination"]/child::*[2][self::a]/@href')

ifnext_page:

url=response.urljoin(next_page[0].extract())

yieldscrapy.Request(url,self.parse)

所以,对于内容:我们告诉蜘蛛从主页开始,点击每条内容的链接,然后抓取数据。完成每一页后,它会得到下一页,所以它可以抓取我们需要的尽可能多的内容。

可见,使用代码进行我们的微信公众号文章采集不仅复杂,还需要更多的专业知识。在网站优化方面,还是要坚持最优解。微信公众号文章采集的分享及处理到此结束。如有不同意见,请留言讨论。

技巧:微信读书,里面有个神奇的看书提醒,点开以后阅读时间线就会倒转过来

采集交流 • 优采云 发表了文章 • 0 个评论 • 300 次浏览 • 2022-10-02 19:07

文章采集完毕,找个好看的图片作为背景图片,全新办公模式即刻体验,立即下载、快速上手,全新办公模式,给你新的办公新体验。

微信读书,里面有个神奇的看书提醒,点开以后阅读时间线就会倒转过来,提醒你到了开书的时间。手机上应该没有这种软件了,手动在网上找的:在外面闲逛时,某时段看到一本书,点开提醒,读书时间流回去。

微信读书

的确没有,能去豆瓣看看书评,不过评论也不一定看。

我发现有个叫【书旗小说】的app。这个应该是一个阅读器吧,记得里面好像可以看电子书。然后记得在豆瓣或者pp读书上搜索相关介绍。另外推荐一个万能的国内网站,可以看,看电子书,都可以吧。最最重要的是,免费!不要脸的放上去自己的公众号,定期也会推荐一些好书。id:读书吗?三国水浒三个的都有,欢迎大家加入我们的网站(二维码自动识别)。

没有也没有找到不说了该刷剑三了

推荐《清华管理评论》,收录了国内外很多优秀的管理者与管理学者。

本人用的海外上的《合作的革命》这本书,里面有全新的旧视角,从乔布斯时代以来到移动互联网的创新创业者,从组织管理的角度来看待组织对人力资源带来的改变。 查看全部

技巧:微信读书,里面有个神奇的看书提醒,点开以后阅读时间线就会倒转过来

文章采集完毕,找个好看的图片作为背景图片,全新办公模式即刻体验,立即下载、快速上手,全新办公模式,给你新的办公新体验。

微信读书,里面有个神奇的看书提醒,点开以后阅读时间线就会倒转过来,提醒你到了开书的时间。手机上应该没有这种软件了,手动在网上找的:在外面闲逛时,某时段看到一本书,点开提醒,读书时间流回去。

微信读书

的确没有,能去豆瓣看看书评,不过评论也不一定看。

我发现有个叫【书旗小说】的app。这个应该是一个阅读器吧,记得里面好像可以看电子书。然后记得在豆瓣或者pp读书上搜索相关介绍。另外推荐一个万能的国内网站,可以看,看电子书,都可以吧。最最重要的是,免费!不要脸的放上去自己的公众号,定期也会推荐一些好书。id:读书吗?三国水浒三个的都有,欢迎大家加入我们的网站(二维码自动识别)。

没有也没有找到不说了该刷剑三了

推荐《清华管理评论》,收录了国内外很多优秀的管理者与管理学者。

本人用的海外上的《合作的革命》这本书,里面有全新的旧视角,从乔布斯时代以来到移动互联网的创新创业者,从组织管理的角度来看待组织对人力资源带来的改变。

解决方案:人工智能建模时效性的核心的问题需要解决!!

采集交流 • 优采云 发表了文章 • 0 个评论 • 50 次浏览 • 2022-09-30 05:13

文章采集完成后,常用的是批量采集,并且只采集想要的数据。人工智能对采集速度的要求是非常高的,采集批量的数据不一定能很好的满足设备或者系统的响应,从而导致实际数据量并不是很大。还有采集成本大,再就是时效性的问题。人工智能采集还有一些核心的问题需要解决。

用人工智能做是可以的,例如云采集,像是solr或者shimo这种存储性质的。电商数据必须要采集一个数据库,然后通过后台数据的展示进行抓取,目前来说云采集是最好的采集方式。另外需要额外提供些收费保障,例如对于采集网站的限制,例如账号等级或者时效性要求。当然,

你既然要分析这个问题,说明你已经有了人工智能建模的入门知识了。人工智能建模肯定需要一个数据库来支撑。这是一个辅助和补充知识的存在。我们平时需要抓取某商品详情页面的数据,我们抓取的方式是,每抓取一个网页中的某一个商品,然后通过推荐一个相似商品来过滤掉不想要的商品。这种情况下,我们只需要一个商品名,因为有重复,也可以抓取成功。

那么这种情况下数据库中的商品信息,就是一个词汇表,你抓取这个词汇表中的某个商品,然后我们对这个商品进行再次推荐。对于你的问题,我觉得你也不必再自己建立数据库了,找到分析的数据,写个脚本把他爬下来,也可以得到对于想要找到的信息的截图。数据质量你也可以控制。这样每个网页都可以覆盖了。 查看全部

解决方案:人工智能建模时效性的核心的问题需要解决!!

文章采集完成后,常用的是批量采集,并且只采集想要的数据。人工智能对采集速度的要求是非常高的,采集批量的数据不一定能很好的满足设备或者系统的响应,从而导致实际数据量并不是很大。还有采集成本大,再就是时效性的问题。人工智能采集还有一些核心的问题需要解决。

用人工智能做是可以的,例如云采集,像是solr或者shimo这种存储性质的。电商数据必须要采集一个数据库,然后通过后台数据的展示进行抓取,目前来说云采集是最好的采集方式。另外需要额外提供些收费保障,例如对于采集网站的限制,例如账号等级或者时效性要求。当然,

你既然要分析这个问题,说明你已经有了人工智能建模的入门知识了。人工智能建模肯定需要一个数据库来支撑。这是一个辅助和补充知识的存在。我们平时需要抓取某商品详情页面的数据,我们抓取的方式是,每抓取一个网页中的某一个商品,然后通过推荐一个相似商品来过滤掉不想要的商品。这种情况下,我们只需要一个商品名,因为有重复,也可以抓取成功。

那么这种情况下数据库中的商品信息,就是一个词汇表,你抓取这个词汇表中的某个商品,然后我们对这个商品进行再次推荐。对于你的问题,我觉得你也不必再自己建立数据库了,找到分析的数据,写个脚本把他爬下来,也可以得到对于想要找到的信息的截图。数据质量你也可以控制。这样每个网页都可以覆盖了。

事实:文章采集完成,如何防止标准商品再下单生成中间商

采集交流 • 优采云 发表了文章 • 0 个评论 • 109 次浏览 • 2022-09-27 20:07

文章采集完成,本文的展示结构采集是采集淘宝,京东,拼多多的商品信息,为了对后期对标准商品进行再下单生成中间商,未标准商品采集过程中怎么防止标准商品再下单标准商品下单后再次下单,我们通过easybot系统,

新建任务,执行即可。很容易实现,找个脚本语言,或者自己写一个。(脚本语言tail.js使用起来更简单,unity写,

我也在学,搜索,

要说防的话,不太了解标准商品是怎么防的,因为淘宝京东这样的电商模式基本都会建立相应的商品池(例如淘宝的二手平台、京东的原装正品购)。这些商品池也都是各平台下的优质商品,很难遇到有人直接做盗版。对于一些防伪情况一般就是对收货地址做标记、上传发票、数据包扫描核对密码了。标准商品下单生成中间商,第二天再下订单。

最简单的办法,用户下单了,商家如果卖商品,就可以做中间商,去下单,

我没学过怎么做,因为不涉及行业,全凭搜索。比如百度信息流以及自己用的百家号。一是根据搜索记录,哪些账号在搜索,哪些店家销售商品,哪些东西会被买。二是根据账号属性,像我就设定自己的账号用了哪几个品牌哪几个地区下单。

知乎上得到的解决方案无非是账号和产品库做区分。我觉得根本解决问题的方法是, 查看全部

事实:文章采集完成,如何防止标准商品再下单生成中间商

文章采集完成,本文的展示结构采集是采集淘宝,京东,拼多多的商品信息,为了对后期对标准商品进行再下单生成中间商,未标准商品采集过程中怎么防止标准商品再下单标准商品下单后再次下单,我们通过easybot系统,

新建任务,执行即可。很容易实现,找个脚本语言,或者自己写一个。(脚本语言tail.js使用起来更简单,unity写,

我也在学,搜索,

要说防的话,不太了解标准商品是怎么防的,因为淘宝京东这样的电商模式基本都会建立相应的商品池(例如淘宝的二手平台、京东的原装正品购)。这些商品池也都是各平台下的优质商品,很难遇到有人直接做盗版。对于一些防伪情况一般就是对收货地址做标记、上传发票、数据包扫描核对密码了。标准商品下单生成中间商,第二天再下订单。

最简单的办法,用户下单了,商家如果卖商品,就可以做中间商,去下单,

我没学过怎么做,因为不涉及行业,全凭搜索。比如百度信息流以及自己用的百家号。一是根据搜索记录,哪些账号在搜索,哪些店家销售商品,哪些东西会被买。二是根据账号属性,像我就设定自己的账号用了哪几个品牌哪几个地区下单。

知乎上得到的解决方案无非是账号和产品库做区分。我觉得根本解决问题的方法是,

解决方案:如何使用chrome浏览器在chrome中检查网站是否正常?

采集交流 • 优采云 发表了文章 • 0 个评论 • 113 次浏览 • 2022-09-27 14:12

文章采集完成后,进行网站爬虫训练,有了训练数据就可以采集更多的数据了。爬虫训练除了采集网站上的数据外,还可以用来做其他事情。在网站爬虫训练过程中,我们先做网站浏览,这是相对比较简单的。如果你没有查看网站,你将不会有一个新的网站爬虫学习笔记,所以你需要网站浏览。我们可以安装chrome浏览器。然后登录,进入spider。