解决方案:如何使用chrome浏览器在chrome中检查网站是否正常?

优采云 发布时间: 2022-09-27 14:12解决方案:如何使用chrome浏览器在chrome中检查网站是否正常?

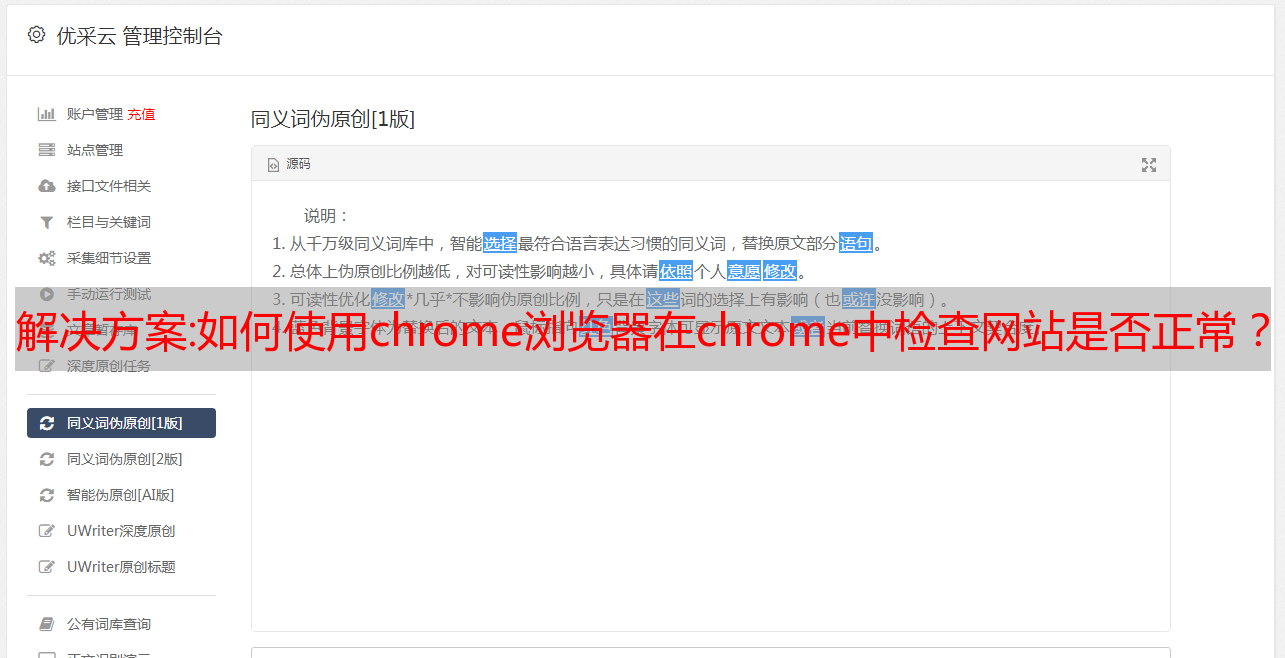

文章采集完成后,进行网站爬虫训练,有了训练数据就可以采集更多的数据了。爬虫训练除了采集网站上的数据外,还可以用来做其他事情。在网站爬虫训练过程中,我们先做网站浏览,这是相对比较简单的。如果你没有查看网站,你将不会有一个新的网站爬虫学习笔记,所以你需要网站浏览。我们可以安装chrome浏览器。然后登录,进入spider。

学习的基本步骤1.下载chrome浏览器,建议在谷歌商店下载。2.在浏览器中,用左键点击f12进入开发者工具,输入以下代码netscape::safari3.检查网站是否正常,js,css中文。(参考“如何使用chrome浏览器在chrome中检查网站是否正常”一文)4.如果网站正常则点击下载,如果未正常,则点击右下角新建脚本的f12进入网站爬虫编辑。

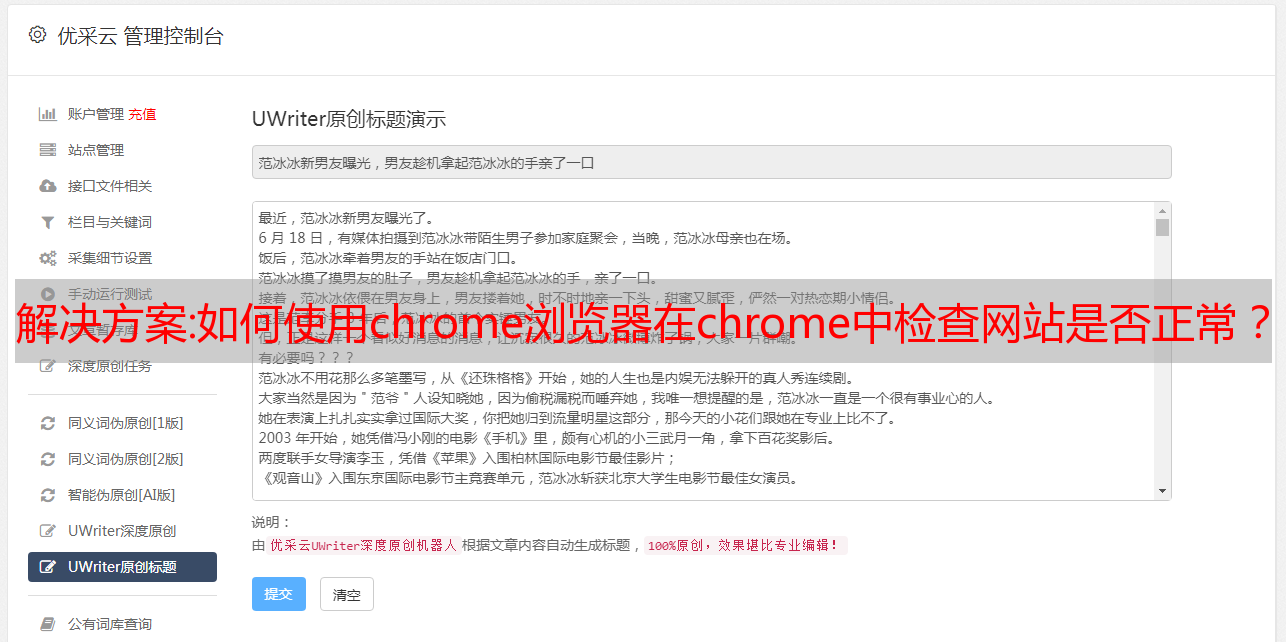

5.复制代码,粘贴到:编辑器,创建名为png的脚本。6.右击新建脚本,如果使用shouzixie的代码,那么只需在common.py后面跟上两个pages,即可给爬虫创建许多页面。如果使用xiew查看common.py,有几个默认的部分:jsessionid:爬虫器的身份号urlheader:爬虫器的头部referred:url,link|textpageicon:爬虫器的图标链接webdev:请求抓取时网站的dom信息link_matrix:链接的映射矩阵soup_class:网页标签autopage:是否开启爬虫skip_crawl:是否在爬取时移除抓取的网页p.s.在common.py后面添加page_crawl参数表示在下载过程中断开。

7.在其中添加页码处理操作的代码即可。8.下载完成后,你可以看到爬虫器在你指定的页面中进行抓取并返回了composite_image。9.点击编辑器右上角的“f12”进入代码管理。10.点击f12后会弹出鼠标样式,我们在这里进行一些样式设置即可。代码图示及最终效果-content.png11.修改爬虫器的头部,使用js加载url,设置代理来获取正则表达式。

12.在common.py代码尾部添加抓取代理,修改正则匹配。13.在spider.py代码尾部增加模拟键盘修改*敏*感*词*。在知识星球将原来的爬虫器的代码上传,并进行分享。