文章网址采集器

文章网址采集器( 网站实时监控自动采集文章内容的操作页:同理)

采集交流 • 优采云 发表了文章 • 0 个评论 • 135 次浏览 • 2021-12-13 09:24

网站实时监控自动采集文章内容的操作页:同理)

网站实时监控和自动更新采集文章内容

该任务的目的是实时监控网站更新,发现更新后立即自动将采集文章内容保存到数据库中。1、首先打开网站信息监控工具,添加监控网页,设置关键词监控,点击保存按钮。

2、添加监控目标URL,按关键词设置监控。

3、 然后点击监控报警选择卡,链接发送到外网口。这里的8888端口是木浏览器设置的接收端口。

4、 然后在木头浏览器的自动控制中打开外部界面,在弹出的对话框中点击开始。里面的端口号是信息监控工具中的外网端口,两个端口必须一致。然后点击信息监控工具的开始监控

5、打开项目管理器,新建一个网页,点击添加按钮,然后在URL上右键选择外部变量中的@link,点击添加添加成功

6、新建一个抓取元素,随便打开一个百度新闻获取,先获取标题,最后获取文章的内容,点击确定添加成功,给元素一个标题,点击添加按钮,元素被添加。同理,添加文章内容

7、 在项目管理中新建一个执行sql,将监控到的数据保存到数据库中。在这种情况下,使用本地数据库。1.选择本地使用的数据库,我这里使用的mysql 5.0版本数据库,然后填写数据库的相应信息,填写后点击测试按钮,如果

8、 然后点击左上角项目中的保存,保存在一个目录下,然后关闭并重新打开外部界面,在运行的项目中点击浏览,选择刚刚保存的项目,然后点击开始查看信息监控工具将监控到的数据保存到数据库中。

9、 然后在信息监控工具中清除信息列表数据,重新开启监控,当相关文章被监控时,数据会发送到木业软件进行处理。

10、 最终运行结果存入数据库

以上就是网站实时监控和自动采集文章使用信息监控工具和木头浏览器结合的操作

页: [1] 查看全部

文章网址采集器(

网站实时监控自动采集文章内容的操作页:同理)

网站实时监控和自动更新采集文章内容

该任务的目的是实时监控网站更新,发现更新后立即自动将采集文章内容保存到数据库中。1、首先打开网站信息监控工具,添加监控网页,设置关键词监控,点击保存按钮。

2、添加监控目标URL,按关键词设置监控。

3、 然后点击监控报警选择卡,链接发送到外网口。这里的8888端口是木浏览器设置的接收端口。

4、 然后在木头浏览器的自动控制中打开外部界面,在弹出的对话框中点击开始。里面的端口号是信息监控工具中的外网端口,两个端口必须一致。然后点击信息监控工具的开始监控

5、打开项目管理器,新建一个网页,点击添加按钮,然后在URL上右键选择外部变量中的@link,点击添加添加成功

6、新建一个抓取元素,随便打开一个百度新闻获取,先获取标题,最后获取文章的内容,点击确定添加成功,给元素一个标题,点击添加按钮,元素被添加。同理,添加文章内容

7、 在项目管理中新建一个执行sql,将监控到的数据保存到数据库中。在这种情况下,使用本地数据库。1.选择本地使用的数据库,我这里使用的mysql 5.0版本数据库,然后填写数据库的相应信息,填写后点击测试按钮,如果

8、 然后点击左上角项目中的保存,保存在一个目录下,然后关闭并重新打开外部界面,在运行的项目中点击浏览,选择刚刚保存的项目,然后点击开始查看信息监控工具将监控到的数据保存到数据库中。

9、 然后在信息监控工具中清除信息列表数据,重新开启监控,当相关文章被监控时,数据会发送到木业软件进行处理。

10、 最终运行结果存入数据库

以上就是网站实时监控和自动采集文章使用信息监控工具和木头浏览器结合的操作

页: [1]

文章网址采集器(图腾网站采集软件提供2种入库方式介绍)

采集交流 • 优采云 发表了文章 • 0 个评论 • 110 次浏览 • 2021-12-13 05:13

【基本介绍】

1、圣者网站采集器简单易用,是一款绿色软件,无需安装,下载解压即可使用;

2、实用性高,内置网站采集功能;

3、只需输入搜索关键词,即可采集上千条数据信息,然后生成网站;

4、可以选择“新闻、文章、电影、视频、图片、关键词”采集选项进行采集定位;

5、使用谷歌网站地图生成器;

6、可设置生成网站的路径、目录名、文件前缀、后缀名,随意HI;

7、12套模板供您选择搭配,生成的网站不再单一;

8、SEO优化了一些需要在内容中插入谷歌广告连接参数的站长;

9、 优化了在文章的内容中随机插入大量关键词的能力;

1个0、生成的网站语言代码可任意设置(简体、繁体、UTF-8);

11、采集随意生成网站广告(对联、浮动、底部);

12、附加HtmlJs互换功能,方便站长使用;

【软件特色】

1、采集 对象不限,只要能连接页面即可(软件设置了N多条采集规则);

问:如果你想采集具体的网站你认为好的信息,请参考《图腾网站采集软件》。他可以自定义写规则,设置采集 Spider。

2、采集对象支持:文章、图片、Flash、视频等。

3、完美的内容存储方案,Sage采集器提供2种存储方式:直接数据库引导和模拟提交。

1)数据库直接引导方式支持任何基于Mysql数据库存储信息的内容管理系统;

2) 模拟提交方式理论上支持任意目标,不受目标程序语言和数据库类别限制;实际使用效果受目标应用影响。

绿色协议本站提供圣人网站采集器 V5.2.3个免费下载,本站所有软件和系统均由软件作者提供,网友推荐,对于仅供学习和研究使用,不得用于任何商业目的。如有侵犯您的版权,请与我们联系,本站将立即更正。 查看全部

文章网址采集器(图腾网站采集软件提供2种入库方式介绍)

【基本介绍】

1、圣者网站采集器简单易用,是一款绿色软件,无需安装,下载解压即可使用;

2、实用性高,内置网站采集功能;

3、只需输入搜索关键词,即可采集上千条数据信息,然后生成网站;

4、可以选择“新闻、文章、电影、视频、图片、关键词”采集选项进行采集定位;

5、使用谷歌网站地图生成器;

6、可设置生成网站的路径、目录名、文件前缀、后缀名,随意HI;

7、12套模板供您选择搭配,生成的网站不再单一;

8、SEO优化了一些需要在内容中插入谷歌广告连接参数的站长;

9、 优化了在文章的内容中随机插入大量关键词的能力;

1个0、生成的网站语言代码可任意设置(简体、繁体、UTF-8);

11、采集随意生成网站广告(对联、浮动、底部);

12、附加HtmlJs互换功能,方便站长使用;

【软件特色】

1、采集 对象不限,只要能连接页面即可(软件设置了N多条采集规则);

问:如果你想采集具体的网站你认为好的信息,请参考《图腾网站采集软件》。他可以自定义写规则,设置采集 Spider。

2、采集对象支持:文章、图片、Flash、视频等。

3、完美的内容存储方案,Sage采集器提供2种存储方式:直接数据库引导和模拟提交。

1)数据库直接引导方式支持任何基于Mysql数据库存储信息的内容管理系统;

2) 模拟提交方式理论上支持任意目标,不受目标程序语言和数据库类别限制;实际使用效果受目标应用影响。

绿色协议本站提供圣人网站采集器 V5.2.3个免费下载,本站所有软件和系统均由软件作者提供,网友推荐,对于仅供学习和研究使用,不得用于任何商业目的。如有侵犯您的版权,请与我们联系,本站将立即更正。

文章网址采集器(蜀戎网络推广服务商SEO服务(新闻资讯)_光明网)

采集交流 • 优采云 发表了文章 • 0 个评论 • 205 次浏览 • 2021-12-13 00:23

树融网络推广服务商

SEO服务新闻 关于舒容

上面的xpath值可以在“Content Paging”Get Paging Area”中设置获取固定区域的分页链接,否则会获取整个页面的分页链接

分页链接规则:

完整分页和上下分页可以直接通过a标签获取链接:

复制代码

JS方式分页通过查看源码发现链接格式为:

复制代码

使用规则匹配分页链接:

复制代码

因为JS模式不能自动补全网址,所以要填写“拼接到最终页面链接”:

【内容一】

复制代码

为了防止非分页链接被匹配,在“内容分页”分页网址过滤“必须收录”中填写“page=”,使用“article/news/pg/id/d+.html?page=d+”为了更精确

下面来测试一下“全分页JS模式”的链接爬取

“测试”爬取分页效果

注意:很多网站由于程序问题都会有2种格式的文章首页链接,比如例子中的文章首页链接:和(来自第二页文章首页就是链接),这两个链接的内容是一样的,会导致文章首页重复爬取

解决方法:在“内容分页”中填写“page=1$”分页网址过滤“不能收录”排除第一页链接

常见问题:

标签:

转载:本站文章均摘自书融网络权威资料、书籍或网络原创文章。如有版权纠纷或侵权,请立即联系我们删除,未经许可禁止复制和转载!感激... 查看全部

文章网址采集器(蜀戎网络推广服务商SEO服务(新闻资讯)_光明网)

树融网络推广服务商

SEO服务新闻 关于舒容

上面的xpath值可以在“Content Paging”Get Paging Area”中设置获取固定区域的分页链接,否则会获取整个页面的分页链接

分页链接规则:

完整分页和上下分页可以直接通过a标签获取链接:

复制代码

JS方式分页通过查看源码发现链接格式为:

复制代码

使用规则匹配分页链接:

复制代码

因为JS模式不能自动补全网址,所以要填写“拼接到最终页面链接”:

【内容一】

复制代码

为了防止非分页链接被匹配,在“内容分页”分页网址过滤“必须收录”中填写“page=”,使用“article/news/pg/id/d+.html?page=d+”为了更精确

下面来测试一下“全分页JS模式”的链接爬取

“测试”爬取分页效果

注意:很多网站由于程序问题都会有2种格式的文章首页链接,比如例子中的文章首页链接:和(来自第二页文章首页就是链接),这两个链接的内容是一样的,会导致文章首页重复爬取

解决方法:在“内容分页”中填写“page=1$”分页网址过滤“不能收录”排除第一页链接

常见问题:

标签:

转载:本站文章均摘自书融网络权威资料、书籍或网络原创文章。如有版权纠纷或侵权,请立即联系我们删除,未经许可禁止复制和转载!感激...

文章网址采集器(优采云采集器V9为例,讲解一个文章采集的实例(组图))

采集交流 • 优采云 发表了文章 • 0 个评论 • 136 次浏览 • 2021-12-05 19:11

在日常工作和学习中,一些对采集有价值的文章可以帮助我们提高信息的利用率和整合率,对于新闻、学术论文等类型的电子文章,我们可以使用网络爬虫工具执行采集,这种采集比较容易比较一些数字化的不规则数据,这里以网络爬虫工具优采云采集器V9为例,解释一个文章采集的例子供大家学习。

熟悉优采云采集器的朋友都知道,采集过程中遇到的问题可以通过官网的FAQ找回,所以这里我们就取采集以faq为例来说明网页爬虫采集的原理和过程。

在这个例子中

演示地址。

(1)创建一个新的采集规则

选择一个组,右击,选择“新建任务”,如下图:

(2)添加起始地址

假设这里我们需要采集 5页数据。

解析URL变量的规律

第一页地址:

第二页地址:

第三页地址:

由此我们可以推断出p=后面的数字是分页的意思,我们用[地址参数]来表示:

所以设置如下:

地址格式:用[地址参数]表示改变的页码。

数字变化:从1开始,即第一页;每增加1,即每页变化的次数;一共5条,也就是一共采集5页。

预览:采集器会根据上面的设置生成一部分URL,让你判断添加的是否正确。

然后确认

(3)【普通模式】获取内容URL

普通模式:该模式默认抓取一级地址,即从起始页的源码中获取到内容页A的链接。

下面我就通过自动获取地址链接+设置区域的方式来教大家如何获取。

查看页面源码,找到文章地址所在的区域:

设置如下:

注:更详细的分析说明请参考本手册:

操作指南> 软件操作> URL 采集规则> 获取内容URL

点击网址采集测试查看测试结果

(3)内容采集网址

经过

以标签为例说明采集

注:更详细的分析说明请参考本手册

操作指南>软件操作>内容采集规则>标签编辑

我们首先查看它的页面源码,找到我们的“title”所在的代码:

导入Excle弹出对话框~打开Excle时出错-优采云采集器帮助中心

分析表明: 开头的字符串是:

结束字符串是:

数据处理-内容替换/排除:需要替换-优采云采集器帮助中心清空

设置内容标签的原理类似,在源码中找到内容的位置

分析表明: 开头的字符串是:

结束字符串是:

数据处理-HTML标签排除:过滤不需要的A链接等。

设置另一个“源”字段

这么简单的文章采集规则就完成了。不知道网友们有没有学到。网络爬虫工具,顾名思义,适用于网页上的数据爬取。从上面的例子大家可以看出,这类软件主要是通过源码分析来分析数据的。还有一些情况这里没有列出,比如登录采集,使用代理采集等,如果你对网络爬虫工具感兴趣,可以登录采集官网@采集器 自学。 查看全部

文章网址采集器(优采云采集器V9为例,讲解一个文章采集的实例(组图))

在日常工作和学习中,一些对采集有价值的文章可以帮助我们提高信息的利用率和整合率,对于新闻、学术论文等类型的电子文章,我们可以使用网络爬虫工具执行采集,这种采集比较容易比较一些数字化的不规则数据,这里以网络爬虫工具优采云采集器V9为例,解释一个文章采集的例子供大家学习。

熟悉优采云采集器的朋友都知道,采集过程中遇到的问题可以通过官网的FAQ找回,所以这里我们就取采集以faq为例来说明网页爬虫采集的原理和过程。

在这个例子中

演示地址。

(1)创建一个新的采集规则

选择一个组,右击,选择“新建任务”,如下图:

(2)添加起始地址

假设这里我们需要采集 5页数据。

解析URL变量的规律

第一页地址:

第二页地址:

第三页地址:

由此我们可以推断出p=后面的数字是分页的意思,我们用[地址参数]来表示:

所以设置如下:

地址格式:用[地址参数]表示改变的页码。

数字变化:从1开始,即第一页;每增加1,即每页变化的次数;一共5条,也就是一共采集5页。

预览:采集器会根据上面的设置生成一部分URL,让你判断添加的是否正确。

然后确认

(3)【普通模式】获取内容URL

普通模式:该模式默认抓取一级地址,即从起始页的源码中获取到内容页A的链接。

下面我就通过自动获取地址链接+设置区域的方式来教大家如何获取。

查看页面源码,找到文章地址所在的区域:

设置如下:

注:更详细的分析说明请参考本手册:

操作指南> 软件操作> URL 采集规则> 获取内容URL

点击网址采集测试查看测试结果

(3)内容采集网址

经过

以标签为例说明采集

注:更详细的分析说明请参考本手册

操作指南>软件操作>内容采集规则>标签编辑

我们首先查看它的页面源码,找到我们的“title”所在的代码:

导入Excle弹出对话框~打开Excle时出错-优采云采集器帮助中心

分析表明: 开头的字符串是:

结束字符串是:

数据处理-内容替换/排除:需要替换-优采云采集器帮助中心清空

设置内容标签的原理类似,在源码中找到内容的位置

分析表明: 开头的字符串是:

结束字符串是:

数据处理-HTML标签排除:过滤不需要的A链接等。

设置另一个“源”字段

这么简单的文章采集规则就完成了。不知道网友们有没有学到。网络爬虫工具,顾名思义,适用于网页上的数据爬取。从上面的例子大家可以看出,这类软件主要是通过源码分析来分析数据的。还有一些情况这里没有列出,比如登录采集,使用代理采集等,如果你对网络爬虫工具感兴趣,可以登录采集官网@采集器 自学。

文章网址采集器(HTTP客户端/awaitawait//async/)

采集交流 • 优采云 发表了文章 • 0 个评论 • 166 次浏览 • 2021-12-05 19:09

HTTP 客户端是一种工具,可以向服务器发送请求,然后接收服务器的响应。下面提到的所有工具的底层都是使用一个HTTP客户端来访问你想要抓取的网站。

要求

Request 是 Javascript 生态系统中使用最广泛的 HTTP 客户端之一,但 Request 库的作者已正式声明它已被弃用。但这并不意味着它不可用,相当多的库仍在使用它,并且非常易于使用。使用 Request 发出 HTTP 请求非常简单:

const request = require('request')

request('https://www.reddit.com/r/programming.json', function ( error,

response,

body) {

console.error('error:', error)

console.log('body:', body)

})

你可以在 Github 上找到 Request 库,安装非常简单。您还可以找到弃用通知及其含义。

阿克西奥斯

Axios 是一个基于 Promise 的 HTTP 客户端,可以在浏览器和 Node.js 中运行。如果您使用 Typescript,那么 axios 将为您覆盖内置类型。通过 Axios 发起 HTTP 请求非常简单。默认情况下,它带有 Promise 支持,而不是在请求中使用回调:

const axios = require('axios')

axios

.get('https://www.reddit.com/r/programming.json')

.then((response) => {

console.log(response)

})

.catch((error) => {

console.error(error)

});

如果你喜欢 Promises API 的 async/await 语法糖,你也可以使用它,但由于顶级 await 仍处于第 3 阶段,我们不得不使用异步函数来代替:

async function getForum() {

try {

const response = await axios.get(

'https://www.reddit.com/r/programming.json'

)

console.log(response)

} catch (error) {

console.error(error)

}

}

您所要做的就是致电 getForum!可以在 Axios 库上找到。

超级代理

与 Axios 一样,Superagent 是另一个强大的 HTTP 客户端,支持 Promise 和 async/await 语法糖。它有一个类似 Axios 的相当简单的 API,但由于更多的依赖关系,Superagent 不太受欢迎。

使用 promise、async/await 或回调向 Superagent 发出 HTTP 请求如下所示:

const superagent = require("superagent")

const forumURL = "https://www.reddit.com/r/programming.json"

// callbacks

superagent

.get(forumURL)

.end((error, response) => {

console.log(response)

})

// promises

superagent

.get(forumURL)

.then((response) => {

console.log(response)

})

.catch((error) => {

console.error(error)

})

// promises with async/await

async function getForum() {

try {

const response = await superagent.get(forumURL)

console.log(response)

} catch (error) {

console.error(error)

}

}

您可以在以下位置找到 Superagent。

正则表达式:艰难的方式

在没有任何依赖的情况下,进行网络爬虫最简单的方法是在使用 HTTP 客户端查询网页时,在接收到的 HTML 字符串上使用一堆正则表达式。正则表达式不是那么灵活,许多专业人士和业余爱好者都很难写出正确的正则表达式。

试试看,假设有一个带有用户名的标签,而我们需要那个用户名,这类似于你依赖正则表达式时必须做的

const htmlString = 'Username: John Doe'

const result = htmlString.match(/(.+)/)

console.log(result[1], result[1].split(": ")[1])

// Username: John Doe, John Doe

在 Javascript 中,match() 通常返回一个数组,其中收录与正则表达式匹配的所有内容。第二个元素(在索引 1 中)将找到我们想要的标记的 textContent 或 innerHTML。但结果收录一些不必要的文本(“用户名:”),必须删除。

如您所见,对于一个非常简单的用例,有许多步骤和工作要做。这就是为什么你应该依赖 HTML 解析器的原因,我们将在后面讨论。

Cheerio:用于遍历 DOM 的核心 JQuery

Cheerio 是一个高效且可移植的库,它允许您在服务器端使用 JQuery 丰富而强大的 API。如果您之前使用过 JQuery,您就会熟悉 Cheerio。它消除了 DOM 的所有不一致和浏览器相关功能,并公开了一个有效的 API 来解析和操作 DOM。

const cheerio = require('cheerio')

const $ = cheerio.load('Hello world')

$('h2.title').text('Hello there!')

$('h2').addClass('welcome')

$.html()

// Hello there!

如您所见,Cheerio 与 JQuery 非常相似。

但是,即使它的工作方式与 Web 浏览器不同,这也意味着它不能:

因此,如果您尝试抓取的网站 或 web 应用程序严重依赖 Javascript(例如“单页应用程序”),那么 Cheerio 不是最佳选择,您可能不得不依赖其他选项稍后讨论。

为了展示 Cheerio 的强大功能,我们将尝试爬取 Reddit 中的 r/programming 论坛,并尝试获取一个帖子名称列表。

首先,通过运行以下命令安装 Cheerio 和 axios:npm installcheerio axios。

然后新建一个名为crawler.js的文件,复制粘贴以下代码:

const axios = require('axios');

const cheerio = require('cheerio');

const getPostTitles = async () => {

try {

const { data } = await axios.get(

'https://old.reddit.com/r/programming/'

);

const $ = cheerio.load(data);

const postTitles = [];

$('div > p.title > a').each((_idx, el) => {

const postTitle = $(el).text()

postTitles.push(postTitle)

});

return postTitles;

} catch (error) {

throw error;

}

};

getPostTitles()

.then((postTitles) => console.log(postTitles));

getPostTitles() 是一个异步函数,它将抓取旧的 reddit r/编程论坛。首先通过axios HTTP客户端库使用简单的HTTP GET请求获取网站的HTML,然后使用cheerio.load()函数将html数据输入到Cheerio中。

然后在浏览器的开发工具的帮助下,你可以得到一个可以定位所有列表项的选择器。如果你用过JQuery,你一定对$('div> p.title> a')非常熟悉。这将获得所有帖子,因为您只想单独获取每个帖子的标题,因此您必须遍历每个帖子。这些操作是在 each() 函数的帮助下完成的。

要从每个标题中提取文本,您必须在 Cheerio 的帮助下获取 DOM 元素(el 指的是当前元素)。然后在每个元素上调用 text() 为您提供文本。

现在,打开终端,运行node crawler.js,你会看到一个近似titles的数组,这个数组会很长。虽然这是一个非常简单的用例,但它展示了 Cheerio 提供的 API 的简单本质。

如果您的用例需要执行 Javascript 并加载外部源,那么以下选项会有所帮助。

JSDOM:节点的 DOM

JSDOM 是 Node.js 中使用的文档对象模型的纯 Javascript 实现。如前所述,DOM 对 Node 不可用,但 JSDOM 是最接近的。它或多或少地模仿了浏览器。

因为DOM是创建的,所以你可以通过编程与web应用或者你想爬取的网站进行交互,也可以模拟点击一个按钮。如果你熟悉 DOM 操作,使用 JSDOM 会非常简单。

const { JSDOM } = require('jsdom')

const { document } = new JSDOM(

'Hello world'

).window

const heading = document.querySelector('.title')

heading.textContent = 'Hello there!'

heading.classList.add('welcome')

heading.innerHTML

// Hello there!

在代码中用JSDOM创建一个DOM,然后你就可以用和浏览器DOM一样的方法和属性来操作这个DOM了。

为了演示如何使用JSDOM与网站进行交互,我们将获取Reddit r/programming论坛的第一篇帖子并对其进行投票,然后验证该帖子是否已被投票。

首先运行以下命令安装jsdom和axios: npm install jsdom axios

然后创建一个名为 crawler.js 的文件,并复制并粘贴以下代码:

const { JSDOM } = require("jsdom")

const axios = require('axios')

const upvoteFirstPost = async () => {

try {

const { data } = await axios.get("https://old.reddit.com/r/programming/");

const dom = new JSDOM(data, {

runScripts: "dangerously",

resources: "usable"

});

const { document } = dom.window;

const firstPost = document.querySelector("div > div.midcol > div.arrow");

firstPost.click();

const isUpvoted = firstPost.classList.contains("upmod");

const msg = isUpvoted

? "Post has been upvoted successfully!"

: "The post has not been upvoted!";

return msg;

} catch (error) {

throw error;

}

};

upvoteFirstPost().then(msg => console.log(msg));

upvoteFirstPost() 是一个异步函数,它将获得 r/programming 中的第一篇文章,然后对其进行投票。axios 发送 HTTP GET 请求以获取指定 URL 的 HTML。然后从之前获得的 HTML 创建一个新的 DOM。JSDOM 构造函数将 HTML 作为第一个参数,将选项作为第二个参数。添加的两个选项执行以下功能:

创建DOM后,使用相同的DOM方法获取第一篇文章文章的upvote按钮,然后点击。要验证它是否真的被点击,您可以检查 classList 中是否有名为 upmod 的类。如果它存在于 classList 中,则返回一条消息。

打开终端并运行 node crawler.js,然后您将看到一个整洁的字符串,表明该帖子是否已被点赞。虽然这个例子很简单,但你可以在这个基础上构建强大的东西,例如,一个对特定用户帖子进行投票的机器人。

如果你不喜欢缺乏表达能力的 JSDOM,并且在实践中依赖很多这样的操作,或者需要重新创建很多不同的 DOM,那么下面的将是更好的选择。

Puppeteer:无头浏览器

顾名思义,Puppeteer 允许您以编程方式操纵浏览器,就像操纵木偶一样。默认情况下,它为开发人员提供了高级 API 来控制无头版本的 Chrome。

Puppeteer 比上述工具更有用,因为它允许您像真人与浏览器交互一样抓取网络。这开辟了一些以前不可用的可能性:

它还可以在网络爬虫以外的任务中发挥重要作用,例如 UI 测试、辅助性能优化等。

通常你想截取网站的截图,也许是为了了解竞争对手的产品目录,你可以使用puppeteer来做。首先运行以下命令安装puppeteer: npm install puppeteer

这将下载 Chromium 的捆绑版本,大约 180 MB 到 300 MB,具体取决于操作系统。如果要禁用此功能。

我们尝试在 Reddit 中获取 r/programming 论坛的截图和 PDF,创建一个名为 crawler.js 的新文件,并复制并粘贴以下代码:

const puppeteer = require('puppeteer')

async function getVisual() {

try {

const URL = 'https://www.reddit.com/r/programming/'

const browser = await puppeteer.launch()

const page = await browser.newPage()

await page.goto(URL)

await page.screenshot({ path: 'screenshot.png' })

await page.pdf({ path: 'page.pdf' })

await browser.close()

} catch (error) {

console.error(error)

}

}

getVisual()

getVisual() 是一个异步函数,它将获取 URL 变量中的 url 对应的屏幕截图和 pdf。首先通过 puppeteer.launch() 创建一个浏览器实例,然后创建一个新页面。您可以将此页面视为常规浏览器中的选项卡。然后以 URL 为参数调用 page.goto() 将之前创建的页面定向到指定的 URL。最终,浏览器实例与页面一起被销毁。

操作完成并加载页面后,将分别使用 page.screenshot() 和 page.pdf() 获取屏幕截图和pdf。也可以监听javascript的load事件,进行这些操作,生产环境中强烈推荐使用。

在终端上运行 node crawler.js。几秒钟后,您会注意到已创建两个文件,名为 screenshot.jpg 和 page.pdf。

Nightmare:Puppeteer 的替代品

Nightmare 是一个类似于 Puppeteer 的高级浏览器自动化库。该库使用 Electron,但据说它的速度是其前身 PhantomJS 的两倍。

如果您在某种程度上不喜欢 Puppeteer 或对 Chromium 包的大小感到沮丧,那么 nightmare 是一个理想的选择。首先,运行以下命令安装 nightmare 库: npm install nightmare

然后,一旦下载了 nightmare,我们将使用它通过 Google 搜索引擎找到 ScrapingBee 的 网站。创建一个名为 crawler.js 的文件,然后将以下代码复制并粘贴到其中:

const Nightmare = require('nightmare')

const nightmare = Nightmare()

nightmare

.goto('https://www.google.com/')

.type("input[title='Search']", 'ScrapingBee')

.click("input[value='Google Search']")

.wait('#rso > div:nth-child(1) > div > div > div.r > a')

.evaluate(

() =>

document.querySelector(

'#rso > div:nth-child(1) > div > div > div.r > a'

).href

)

.end()

.then((link) => {

console.log('Scraping Bee Web Link': link)

})

.catch((error) => {

console.error('Search failed:', error)

})

首先创建一个 Nightmare 实例,然后通过调用 goto() 将该实例定向到 Google 搜索引擎。加载后,使用其选择器获取搜索框,然后使用搜索框的值(输入标签)将其更改为“ScrapingBee”。完成后,单击“Google 搜索”按钮提交搜索表单。然后告诉 Nightmare 等到第一个链接加载完毕。一旦完成,它将使用 DOM 方法获取收录链接的锚标记的 href 属性的值。

最后,在所有操作完成后,将链接打印到控制台。

总结 查看全部

文章网址采集器(HTTP客户端/awaitawait//async/)

HTTP 客户端是一种工具,可以向服务器发送请求,然后接收服务器的响应。下面提到的所有工具的底层都是使用一个HTTP客户端来访问你想要抓取的网站。

要求

Request 是 Javascript 生态系统中使用最广泛的 HTTP 客户端之一,但 Request 库的作者已正式声明它已被弃用。但这并不意味着它不可用,相当多的库仍在使用它,并且非常易于使用。使用 Request 发出 HTTP 请求非常简单:

const request = require('request')

request('https://www.reddit.com/r/programming.json', function ( error,

response,

body) {

console.error('error:', error)

console.log('body:', body)

})

你可以在 Github 上找到 Request 库,安装非常简单。您还可以找到弃用通知及其含义。

阿克西奥斯

Axios 是一个基于 Promise 的 HTTP 客户端,可以在浏览器和 Node.js 中运行。如果您使用 Typescript,那么 axios 将为您覆盖内置类型。通过 Axios 发起 HTTP 请求非常简单。默认情况下,它带有 Promise 支持,而不是在请求中使用回调:

const axios = require('axios')

axios

.get('https://www.reddit.com/r/programming.json')

.then((response) => {

console.log(response)

})

.catch((error) => {

console.error(error)

});

如果你喜欢 Promises API 的 async/await 语法糖,你也可以使用它,但由于顶级 await 仍处于第 3 阶段,我们不得不使用异步函数来代替:

async function getForum() {

try {

const response = await axios.get(

'https://www.reddit.com/r/programming.json'

)

console.log(response)

} catch (error) {

console.error(error)

}

}

您所要做的就是致电 getForum!可以在 Axios 库上找到。

超级代理

与 Axios 一样,Superagent 是另一个强大的 HTTP 客户端,支持 Promise 和 async/await 语法糖。它有一个类似 Axios 的相当简单的 API,但由于更多的依赖关系,Superagent 不太受欢迎。

使用 promise、async/await 或回调向 Superagent 发出 HTTP 请求如下所示:

const superagent = require("superagent")

const forumURL = "https://www.reddit.com/r/programming.json"

// callbacks

superagent

.get(forumURL)

.end((error, response) => {

console.log(response)

})

// promises

superagent

.get(forumURL)

.then((response) => {

console.log(response)

})

.catch((error) => {

console.error(error)

})

// promises with async/await

async function getForum() {

try {

const response = await superagent.get(forumURL)

console.log(response)

} catch (error) {

console.error(error)

}

}

您可以在以下位置找到 Superagent。

正则表达式:艰难的方式

在没有任何依赖的情况下,进行网络爬虫最简单的方法是在使用 HTTP 客户端查询网页时,在接收到的 HTML 字符串上使用一堆正则表达式。正则表达式不是那么灵活,许多专业人士和业余爱好者都很难写出正确的正则表达式。

试试看,假设有一个带有用户名的标签,而我们需要那个用户名,这类似于你依赖正则表达式时必须做的

const htmlString = 'Username: John Doe'

const result = htmlString.match(/(.+)/)

console.log(result[1], result[1].split(": ")[1])

// Username: John Doe, John Doe

在 Javascript 中,match() 通常返回一个数组,其中收录与正则表达式匹配的所有内容。第二个元素(在索引 1 中)将找到我们想要的标记的 textContent 或 innerHTML。但结果收录一些不必要的文本(“用户名:”),必须删除。

如您所见,对于一个非常简单的用例,有许多步骤和工作要做。这就是为什么你应该依赖 HTML 解析器的原因,我们将在后面讨论。

Cheerio:用于遍历 DOM 的核心 JQuery

Cheerio 是一个高效且可移植的库,它允许您在服务器端使用 JQuery 丰富而强大的 API。如果您之前使用过 JQuery,您就会熟悉 Cheerio。它消除了 DOM 的所有不一致和浏览器相关功能,并公开了一个有效的 API 来解析和操作 DOM。

const cheerio = require('cheerio')

const $ = cheerio.load('Hello world')

$('h2.title').text('Hello there!')

$('h2').addClass('welcome')

$.html()

// Hello there!

如您所见,Cheerio 与 JQuery 非常相似。

但是,即使它的工作方式与 Web 浏览器不同,这也意味着它不能:

因此,如果您尝试抓取的网站 或 web 应用程序严重依赖 Javascript(例如“单页应用程序”),那么 Cheerio 不是最佳选择,您可能不得不依赖其他选项稍后讨论。

为了展示 Cheerio 的强大功能,我们将尝试爬取 Reddit 中的 r/programming 论坛,并尝试获取一个帖子名称列表。

首先,通过运行以下命令安装 Cheerio 和 axios:npm installcheerio axios。

然后新建一个名为crawler.js的文件,复制粘贴以下代码:

const axios = require('axios');

const cheerio = require('cheerio');

const getPostTitles = async () => {

try {

const { data } = await axios.get(

'https://old.reddit.com/r/programming/'

);

const $ = cheerio.load(data);

const postTitles = [];

$('div > p.title > a').each((_idx, el) => {

const postTitle = $(el).text()

postTitles.push(postTitle)

});

return postTitles;

} catch (error) {

throw error;

}

};

getPostTitles()

.then((postTitles) => console.log(postTitles));

getPostTitles() 是一个异步函数,它将抓取旧的 reddit r/编程论坛。首先通过axios HTTP客户端库使用简单的HTTP GET请求获取网站的HTML,然后使用cheerio.load()函数将html数据输入到Cheerio中。

然后在浏览器的开发工具的帮助下,你可以得到一个可以定位所有列表项的选择器。如果你用过JQuery,你一定对$('div> p.title> a')非常熟悉。这将获得所有帖子,因为您只想单独获取每个帖子的标题,因此您必须遍历每个帖子。这些操作是在 each() 函数的帮助下完成的。

要从每个标题中提取文本,您必须在 Cheerio 的帮助下获取 DOM 元素(el 指的是当前元素)。然后在每个元素上调用 text() 为您提供文本。

现在,打开终端,运行node crawler.js,你会看到一个近似titles的数组,这个数组会很长。虽然这是一个非常简单的用例,但它展示了 Cheerio 提供的 API 的简单本质。

如果您的用例需要执行 Javascript 并加载外部源,那么以下选项会有所帮助。

JSDOM:节点的 DOM

JSDOM 是 Node.js 中使用的文档对象模型的纯 Javascript 实现。如前所述,DOM 对 Node 不可用,但 JSDOM 是最接近的。它或多或少地模仿了浏览器。

因为DOM是创建的,所以你可以通过编程与web应用或者你想爬取的网站进行交互,也可以模拟点击一个按钮。如果你熟悉 DOM 操作,使用 JSDOM 会非常简单。

const { JSDOM } = require('jsdom')

const { document } = new JSDOM(

'Hello world'

).window

const heading = document.querySelector('.title')

heading.textContent = 'Hello there!'

heading.classList.add('welcome')

heading.innerHTML

// Hello there!

在代码中用JSDOM创建一个DOM,然后你就可以用和浏览器DOM一样的方法和属性来操作这个DOM了。

为了演示如何使用JSDOM与网站进行交互,我们将获取Reddit r/programming论坛的第一篇帖子并对其进行投票,然后验证该帖子是否已被投票。

首先运行以下命令安装jsdom和axios: npm install jsdom axios

然后创建一个名为 crawler.js 的文件,并复制并粘贴以下代码:

const { JSDOM } = require("jsdom")

const axios = require('axios')

const upvoteFirstPost = async () => {

try {

const { data } = await axios.get("https://old.reddit.com/r/programming/";);

const dom = new JSDOM(data, {

runScripts: "dangerously",

resources: "usable"

});

const { document } = dom.window;

const firstPost = document.querySelector("div > div.midcol > div.arrow");

firstPost.click();

const isUpvoted = firstPost.classList.contains("upmod");

const msg = isUpvoted

? "Post has been upvoted successfully!"

: "The post has not been upvoted!";

return msg;

} catch (error) {

throw error;

}

};

upvoteFirstPost().then(msg => console.log(msg));

upvoteFirstPost() 是一个异步函数,它将获得 r/programming 中的第一篇文章,然后对其进行投票。axios 发送 HTTP GET 请求以获取指定 URL 的 HTML。然后从之前获得的 HTML 创建一个新的 DOM。JSDOM 构造函数将 HTML 作为第一个参数,将选项作为第二个参数。添加的两个选项执行以下功能:

创建DOM后,使用相同的DOM方法获取第一篇文章文章的upvote按钮,然后点击。要验证它是否真的被点击,您可以检查 classList 中是否有名为 upmod 的类。如果它存在于 classList 中,则返回一条消息。

打开终端并运行 node crawler.js,然后您将看到一个整洁的字符串,表明该帖子是否已被点赞。虽然这个例子很简单,但你可以在这个基础上构建强大的东西,例如,一个对特定用户帖子进行投票的机器人。

如果你不喜欢缺乏表达能力的 JSDOM,并且在实践中依赖很多这样的操作,或者需要重新创建很多不同的 DOM,那么下面的将是更好的选择。

Puppeteer:无头浏览器

顾名思义,Puppeteer 允许您以编程方式操纵浏览器,就像操纵木偶一样。默认情况下,它为开发人员提供了高级 API 来控制无头版本的 Chrome。

Puppeteer 比上述工具更有用,因为它允许您像真人与浏览器交互一样抓取网络。这开辟了一些以前不可用的可能性:

它还可以在网络爬虫以外的任务中发挥重要作用,例如 UI 测试、辅助性能优化等。

通常你想截取网站的截图,也许是为了了解竞争对手的产品目录,你可以使用puppeteer来做。首先运行以下命令安装puppeteer: npm install puppeteer

这将下载 Chromium 的捆绑版本,大约 180 MB 到 300 MB,具体取决于操作系统。如果要禁用此功能。

我们尝试在 Reddit 中获取 r/programming 论坛的截图和 PDF,创建一个名为 crawler.js 的新文件,并复制并粘贴以下代码:

const puppeteer = require('puppeteer')

async function getVisual() {

try {

const URL = 'https://www.reddit.com/r/programming/'

const browser = await puppeteer.launch()

const page = await browser.newPage()

await page.goto(URL)

await page.screenshot({ path: 'screenshot.png' })

await page.pdf({ path: 'page.pdf' })

await browser.close()

} catch (error) {

console.error(error)

}

}

getVisual()

getVisual() 是一个异步函数,它将获取 URL 变量中的 url 对应的屏幕截图和 pdf。首先通过 puppeteer.launch() 创建一个浏览器实例,然后创建一个新页面。您可以将此页面视为常规浏览器中的选项卡。然后以 URL 为参数调用 page.goto() 将之前创建的页面定向到指定的 URL。最终,浏览器实例与页面一起被销毁。

操作完成并加载页面后,将分别使用 page.screenshot() 和 page.pdf() 获取屏幕截图和pdf。也可以监听javascript的load事件,进行这些操作,生产环境中强烈推荐使用。

在终端上运行 node crawler.js。几秒钟后,您会注意到已创建两个文件,名为 screenshot.jpg 和 page.pdf。

Nightmare:Puppeteer 的替代品

Nightmare 是一个类似于 Puppeteer 的高级浏览器自动化库。该库使用 Electron,但据说它的速度是其前身 PhantomJS 的两倍。

如果您在某种程度上不喜欢 Puppeteer 或对 Chromium 包的大小感到沮丧,那么 nightmare 是一个理想的选择。首先,运行以下命令安装 nightmare 库: npm install nightmare

然后,一旦下载了 nightmare,我们将使用它通过 Google 搜索引擎找到 ScrapingBee 的 网站。创建一个名为 crawler.js 的文件,然后将以下代码复制并粘贴到其中:

const Nightmare = require('nightmare')

const nightmare = Nightmare()

nightmare

.goto('https://www.google.com/')

.type("input[title='Search']", 'ScrapingBee')

.click("input[value='Google Search']")

.wait('#rso > div:nth-child(1) > div > div > div.r > a')

.evaluate(

() =>

document.querySelector(

'#rso > div:nth-child(1) > div > div > div.r > a'

).href

)

.end()

.then((link) => {

console.log('Scraping Bee Web Link': link)

})

.catch((error) => {

console.error('Search failed:', error)

})

首先创建一个 Nightmare 实例,然后通过调用 goto() 将该实例定向到 Google 搜索引擎。加载后,使用其选择器获取搜索框,然后使用搜索框的值(输入标签)将其更改为“ScrapingBee”。完成后,单击“Google 搜索”按钮提交搜索表单。然后告诉 Nightmare 等到第一个链接加载完毕。一旦完成,它将使用 DOM 方法获取收录链接的锚标记的 href 属性的值。

最后,在所有操作完成后,将链接打印到控制台。

总结

文章网址采集器(爬虫技术使用不当非法途径)

采集交流 • 优采云 发表了文章 • 0 个评论 • 124 次浏览 • 2021-12-05 19:08

免责声明:本文仅供学习使用,禁止非法使用。爬虫技术使用不当造成的一切不良后果与我无关

需要使用的库和模块要获取的信息

网站

首先我们要确定我们想要得到什么数据

主要步骤

(一)构建请求头

headers = {

'User-Agent': '****************',#可填入自己的

}

base_url = 'http://www.aixiawx.com/27/27010/'

(二)解析URL参数的规则

刚打开小说的一章,可以看到url参数在增加,对吗?

但是一开始我观察到这里的URL有递增规律,所以没多看几眼,然后用遍历,出现了Error。

最后我测试了一下,发现有些章节不符合规律,所以不能用这个方法来遍历URL。

我能做什么?

在目录页面上有所有章节的 url 链接

可以抓取章节页面的url,形成一个列表,然后遍历列表,获取每个章节的链接

目录页面分析

从章节数来看,label是最合适的选择label,所以我们使用label来获取章节链接的top index

代码显示如下:

<p>def analysis_catalogue(catalogue_html: "目录HTML文档"):

'''

解析目录HTMl文档

获取小说章节链接

对章节链接排序

'''

html = etree.HTML(catalogue_html)

contentds = html.xpath('//dd[position()>9]/a/@href')

for contentd in contentds:

yield contentd

contentus = html.xpath('//dd[position()9]/a/@href')

for contentd in contentds:

yield contentd

contentus = html.xpath('//dd[position() 查看全部

文章网址采集器(爬虫技术使用不当非法途径)

免责声明:本文仅供学习使用,禁止非法使用。爬虫技术使用不当造成的一切不良后果与我无关

需要使用的库和模块要获取的信息

网站

首先我们要确定我们想要得到什么数据

主要步骤

(一)构建请求头

headers = {

'User-Agent': '****************',#可填入自己的

}

base_url = 'http://www.aixiawx.com/27/27010/'

(二)解析URL参数的规则

刚打开小说的一章,可以看到url参数在增加,对吗?

但是一开始我观察到这里的URL有递增规律,所以没多看几眼,然后用遍历,出现了Error。

最后我测试了一下,发现有些章节不符合规律,所以不能用这个方法来遍历URL。

我能做什么?

在目录页面上有所有章节的 url 链接

可以抓取章节页面的url,形成一个列表,然后遍历列表,获取每个章节的链接

目录页面分析

从章节数来看,label是最合适的选择label,所以我们使用label来获取章节链接的top index

代码显示如下:

<p>def analysis_catalogue(catalogue_html: "目录HTML文档"):

'''

解析目录HTMl文档

获取小说章节链接

对章节链接排序

'''

html = etree.HTML(catalogue_html)

contentds = html.xpath('//dd[position()>9]/a/@href')

for contentd in contentds:

yield contentd

contentus = html.xpath('//dd[position()9]/a/@href')

for contentd in contentds:

yield contentd

contentus = html.xpath('//dd[position()

文章网址采集器(众大云采集Discuz版的功能特点及特点介绍-温馨提示 )

采集交流 • 优采云 发表了文章 • 0 个评论 • 109 次浏览 • 2021-12-05 02:07

)

中大云采集Discuz版是专门为discuz开发的一批采集软件。安装此插件后,采集器 控制面板将出现在用于发布帖子、门户和群组的页面顶部。在发布编辑框中输入 关键词 或 URL smart 采集。支持 易学易懂易使用,成熟稳定。是一个供新手站长和网站编辑使用的discuz插件。

【提示】

01、安装本插件后,您可以输入新闻信息网址或关键词,一键批量采集任意新闻信息内容到您的论坛版块或门户栏目,群发。

02、可以将已成功发布的内容推送到百度数据收录界面进行SEO优化,采集和收录双赢。

03、插件可以设置定时采集关键词,然后自动发布内容,实现网站内容的无人值守自动更新。

04、 插件上线已经一年多了。根据大量用户反馈,经过多次升级更新,该插件功能成熟稳定,通俗易懂,使用方便,功能强大。它已被许多网站管理员安装和使用。站长必备插件!

【本插件的特点】

01、 可以批量注册马甲用户,发帖和评论使用的马甲与真实注册用户发布的马甲一模一样。

02、您可以采集批量发布,短时间内将任何优质内容转发到您的论坛和门户。

03、可调度采集并自动释放,实现无人值守。

04、采集 返回的内容可以进行简繁体转换,可以做伪原创等二次处理。

05、支持前台采集,可以授权指定的普通注册用户在前台使用这个采集器,让普通注册会员帮你采集的内容。

06、采集 过来的内容图片可以正常显示并保存为帖子图片附件或门户文章附件,图片永不丢失。

07、 图片附件支持远程FTP存储,可以将图片分开到另一台服务器。

08、 图片将添加您的论坛或门户设置的水印。

09、 已经采集的内容不会重复两次采集,内容不会重复或冗余。

1 0、采集或门户网站文章发布的帖子,群组与真实用户发布的完全相同,其他人无法知道是否以采集器发布。

1 1、的浏览量会自动随机设置。感觉你的帖子或门户文章的浏览量和真实的一样。

12、可以指定帖子发布者(主持人)、门户文章作者、群发帖者。

1 3、采集的内容可以发到论坛任意版块、门户任意栏目、群任意圈。

14、发布的内容可以推送到百度数据收录界面进行SEO优化,加快网站的百度索引量和收录的索引量。

15、不限制采集的内容数量,不限制采集的次数,让你的网站快速填充优质内容.

16、插件内置正文提取算法,支持采集任意网站任意栏目内容。

17、 一键获取当前实时热点内容,然后一键发布。

【这个插件给你带来的价值】

1、 让你的论坛注册会员多,人气高,内容丰富。

2、采用定时发布、自动采集、一键批量采集等方式代替人工发布,省时、省力、高效,不易出错。

3、让您的网站与海量知名新闻网站分享优质内容,快速提升网站的权重和排名。

【用户保障】

1、 严格遵守官方插件开发规范。此外,我们的团队也会对插件进行大量的测试,以确保插件的安全、稳定和成熟。

2、 购买此插件后,由于服务器运行环境、插件冲突、系统配置等原因无法使用该插件,可联系技术人员帮助解决。购买插件后,您不必担心不会使用它。如果你真的不能使用它,你就不会收到它。你有一分钱。

3、在使用过程中,如有BUG或用户体验不佳,可向技术人员反馈。经评估,情况属实,将在下一个升级版本中解决。请关注插件升级更新。

v9.6.8 更新升级如下:

1.采集,您可以采集回复。

2.增加无人值守自动采集功能。安装此插件后,您可以自动发布内容并为您做SEO支持。

3.添加当天内容的自动采集***。

4.添加近期实时热点内容采集。

5.添加批量采集的功能。

6.进一步优化chrome扩展,实时一键采集任何你想要的内容。

7. 进一步优化图像定位存储功能。

8.添加前端论坛、门户和群组。发帖时,有一个采集控制面板。

9.前台采集面板,输入内容页面的URL,内容会自动提取。

v9.7.0 更新如下:

1.插件后台批处理采集和自动定时采集,添加实时采集选项解决特定关键词批处理采集,内容音量太小问题!!

2.前台采集控制面板,增加【图片定位】功能。

查看全部

文章网址采集器(众大云采集Discuz版的功能特点及特点介绍-温馨提示

)

中大云采集Discuz版是专门为discuz开发的一批采集软件。安装此插件后,采集器 控制面板将出现在用于发布帖子、门户和群组的页面顶部。在发布编辑框中输入 关键词 或 URL smart 采集。支持 易学易懂易使用,成熟稳定。是一个供新手站长和网站编辑使用的discuz插件。

【提示】

01、安装本插件后,您可以输入新闻信息网址或关键词,一键批量采集任意新闻信息内容到您的论坛版块或门户栏目,群发。

02、可以将已成功发布的内容推送到百度数据收录界面进行SEO优化,采集和收录双赢。

03、插件可以设置定时采集关键词,然后自动发布内容,实现网站内容的无人值守自动更新。

04、 插件上线已经一年多了。根据大量用户反馈,经过多次升级更新,该插件功能成熟稳定,通俗易懂,使用方便,功能强大。它已被许多网站管理员安装和使用。站长必备插件!

【本插件的特点】

01、 可以批量注册马甲用户,发帖和评论使用的马甲与真实注册用户发布的马甲一模一样。

02、您可以采集批量发布,短时间内将任何优质内容转发到您的论坛和门户。

03、可调度采集并自动释放,实现无人值守。

04、采集 返回的内容可以进行简繁体转换,可以做伪原创等二次处理。

05、支持前台采集,可以授权指定的普通注册用户在前台使用这个采集器,让普通注册会员帮你采集的内容。

06、采集 过来的内容图片可以正常显示并保存为帖子图片附件或门户文章附件,图片永不丢失。

07、 图片附件支持远程FTP存储,可以将图片分开到另一台服务器。

08、 图片将添加您的论坛或门户设置的水印。

09、 已经采集的内容不会重复两次采集,内容不会重复或冗余。

1 0、采集或门户网站文章发布的帖子,群组与真实用户发布的完全相同,其他人无法知道是否以采集器发布。

1 1、的浏览量会自动随机设置。感觉你的帖子或门户文章的浏览量和真实的一样。

12、可以指定帖子发布者(主持人)、门户文章作者、群发帖者。

1 3、采集的内容可以发到论坛任意版块、门户任意栏目、群任意圈。

14、发布的内容可以推送到百度数据收录界面进行SEO优化,加快网站的百度索引量和收录的索引量。

15、不限制采集的内容数量,不限制采集的次数,让你的网站快速填充优质内容.

16、插件内置正文提取算法,支持采集任意网站任意栏目内容。

17、 一键获取当前实时热点内容,然后一键发布。

【这个插件给你带来的价值】

1、 让你的论坛注册会员多,人气高,内容丰富。

2、采用定时发布、自动采集、一键批量采集等方式代替人工发布,省时、省力、高效,不易出错。

3、让您的网站与海量知名新闻网站分享优质内容,快速提升网站的权重和排名。

【用户保障】

1、 严格遵守官方插件开发规范。此外,我们的团队也会对插件进行大量的测试,以确保插件的安全、稳定和成熟。

2、 购买此插件后,由于服务器运行环境、插件冲突、系统配置等原因无法使用该插件,可联系技术人员帮助解决。购买插件后,您不必担心不会使用它。如果你真的不能使用它,你就不会收到它。你有一分钱。

3、在使用过程中,如有BUG或用户体验不佳,可向技术人员反馈。经评估,情况属实,将在下一个升级版本中解决。请关注插件升级更新。

v9.6.8 更新升级如下:

1.采集,您可以采集回复。

2.增加无人值守自动采集功能。安装此插件后,您可以自动发布内容并为您做SEO支持。

3.添加当天内容的自动采集***。

4.添加近期实时热点内容采集。

5.添加批量采集的功能。

6.进一步优化chrome扩展,实时一键采集任何你想要的内容。

7. 进一步优化图像定位存储功能。

8.添加前端论坛、门户和群组。发帖时,有一个采集控制面板。

9.前台采集面板,输入内容页面的URL,内容会自动提取。

v9.7.0 更新如下:

1.插件后台批处理采集和自动定时采集,添加实时采集选项解决特定关键词批处理采集,内容音量太小问题!!

2.前台采集控制面板,增加【图片定位】功能。

文章网址采集器(优采云采集器如何根据下载链接批量下载文件的所有内容)

采集交流 • 优采云 发表了文章 • 0 个评论 • 165 次浏览 • 2021-11-29 14:11

最近遇到一个问题,可以拿到文件的真实下载地址(地址是加密的),用浏览器打开,直接下载。我尝试用迅雷批量下载,但我得到的只是php文件。如果只有一两个文件,最好用浏览器直接下载就可以了,但是如果地址很多怎么办?今天教大家如何通过优采云采集器批量下载?

一般来说,我们对采集一个网站文件的正常思路是这样的:

1、获取具体分类列表页面地址,从而获取内容页面地址;

2、 获取下载页面地址,最后在下载页面获取最终下载地址即可下载

上面的想法是一个正常的想法,但是最近遇到的问题有点棘手。最终下载地址只能在下载页面通过其他方式获取(虽然最终下载地址是加密的),下载地址手动也可以复制到浏览器下载,Pin也找到了简单的打开方式一次性批量处理这些下载地址,然后可以批量打开网页,然后文件会自动保存到同一个文件夹中。但是如果你想通过或head 采集器解决问题怎么办?

还以为曾经写过一篇文章优采云采集器的文章,通过正则抽取的方式获取当前页面的URL,这样我们就可以通过采集当前的URL来获取当前的URL链接link as 文件下载链接用于在优采云采集器中批量下载。

需要注意的是,按照之前的思路,采集做的分类页和内容页,包括最终的文件下载链接,都是一个地址,但这不影响我们的批处理采集下载。

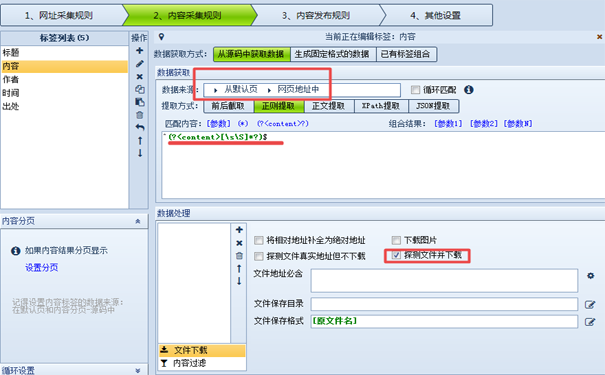

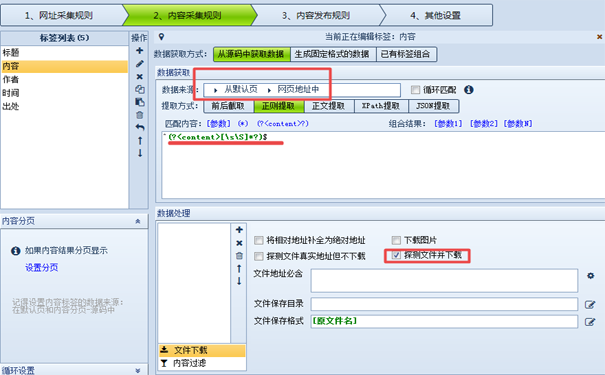

具体可以在优采云采集器中进行如下设置:

在 URL 采集 规则下,设置“起始 URL 是内容页面的 URL”

在内容采集规则下设置“数据源”、“匹配内容”和“文件下载”如下:

定时抽取的代码请参考优采云采集器定时抽取获取当前页面URL进行设置。

上面圈出了几个需要设置的关键参数,其他参数可以根据需要设置。以上是关于如何优采云采集器根据下载链接批量下载文件的所有内容。欢迎有问题的朋友一起交流。

您可能感兴趣文章优采云采集器软件V7.6 绿色版,免安装,免下载,功能无限使用,分享给大家优采云 采集器从零基础到精通的全套视频课程优采云采集器高铁V9快乐版采集器,兼容win10全功能版优采云采集器https网站不能采集解决方案优采云V9快乐版优采云,内网加密狗版9.8 无限使用功能该网页具有未关闭的标签,并且无法在此页面上使用 XPath。解决SQLite Expert Professional解析提取信息问题5.3优采云db3数据库编辑软件优采云采集器定时提取获取当前页面URL 查看全部

文章网址采集器(优采云采集器如何根据下载链接批量下载文件的所有内容)

最近遇到一个问题,可以拿到文件的真实下载地址(地址是加密的),用浏览器打开,直接下载。我尝试用迅雷批量下载,但我得到的只是php文件。如果只有一两个文件,最好用浏览器直接下载就可以了,但是如果地址很多怎么办?今天教大家如何通过优采云采集器批量下载?

一般来说,我们对采集一个网站文件的正常思路是这样的:

1、获取具体分类列表页面地址,从而获取内容页面地址;

2、 获取下载页面地址,最后在下载页面获取最终下载地址即可下载

上面的想法是一个正常的想法,但是最近遇到的问题有点棘手。最终下载地址只能在下载页面通过其他方式获取(虽然最终下载地址是加密的),下载地址手动也可以复制到浏览器下载,Pin也找到了简单的打开方式一次性批量处理这些下载地址,然后可以批量打开网页,然后文件会自动保存到同一个文件夹中。但是如果你想通过或head 采集器解决问题怎么办?

还以为曾经写过一篇文章优采云采集器的文章,通过正则抽取的方式获取当前页面的URL,这样我们就可以通过采集当前的URL来获取当前的URL链接link as 文件下载链接用于在优采云采集器中批量下载。

需要注意的是,按照之前的思路,采集做的分类页和内容页,包括最终的文件下载链接,都是一个地址,但这不影响我们的批处理采集下载。

具体可以在优采云采集器中进行如下设置:

在 URL 采集 规则下,设置“起始 URL 是内容页面的 URL”

在内容采集规则下设置“数据源”、“匹配内容”和“文件下载”如下:

定时抽取的代码请参考优采云采集器定时抽取获取当前页面URL进行设置。

上面圈出了几个需要设置的关键参数,其他参数可以根据需要设置。以上是关于如何优采云采集器根据下载链接批量下载文件的所有内容。欢迎有问题的朋友一起交流。

您可能感兴趣文章优采云采集器软件V7.6 绿色版,免安装,免下载,功能无限使用,分享给大家优采云 采集器从零基础到精通的全套视频课程优采云采集器高铁V9快乐版采集器,兼容win10全功能版优采云采集器https网站不能采集解决方案优采云V9快乐版优采云,内网加密狗版9.8 无限使用功能该网页具有未关闭的标签,并且无法在此页面上使用 XPath。解决SQLite Expert Professional解析提取信息问题5.3优采云db3数据库编辑软件优采云采集器定时提取获取当前页面URL

文章网址采集器( 或者说发帖的人根本就是放下诱饵,存心就是就源源不断地飘过来了)

采集交流 • 优采云 发表了文章 • 0 个评论 • 147 次浏览 • 2021-11-28 02:24

或者说发帖的人根本就是放下诱饵,存心就是就源源不断地飘过来了)

有时,在与网友交流的过程中,您或您的读者会无意中在文章的内容或评论中留下您的邮箱。你可能会遇到的问题是你的邮箱会被采集器收走,垃圾邮件会像洪水一样泛滥。

幸运的是,WordPress 具有反垃圾邮件机器人功能,可以帮助我们对电子邮件地址进行转义,以便 采集器 无法识别电子邮件地址并保护您的邮箱免受垃圾邮件的侵害。同时,它允许其他网民自由复制他们的电子邮件地址,而不必将其制作成图片形式,从而影响用户体验。

执行

将以下 php 代码复制并粘贴到您当前主题的 functions.php 中。保存后,WordPress会自动对文章的内容和评论内容中的邮箱地址进行转义(不会影响其他地方的邮箱):

/**

* WordPress 防止邮箱采集器收集文章和评论中的 Email 地址

* https://www.ilxtx.com/automati ... .html

*/

function lxtx_security_remove_emails($content) {

$pattern = '/([a-zA-Z0-9._%+-]+@[a-zA-Z0-9.-]+\.[a-zA-Z]{2,4})/i';

$fix = preg_replace_callback($pattern, "lxtx_security_remove_emails_logic", $content);

return $fix;

}

function lxtx_security_remove_emails_logic($result) {

return antispambot($result[1]);

}

add_filter( 'the_content', 'lxtx_security_remove_emails', 20 );

add_filter( 'comment_text', 'lxtx_security_remove_emails', 20 );

使用说明

添加上述代码后,您可以尝试在您的文章之一中输入电子邮件地址,更新此文章的源代码后,您将看到转义的电子邮件地址。

例如电子邮件地址:

转义后在源码中看到的是:(具体效果请查看本文源码~)

邮箱地址采集器都是从源码到采集邮箱地址,转义的内容他们几乎认不出来。虽然你会在源码中看到一堆乱码,但是我们还是可以在你的文章和评论中看到正常的邮箱地址,可以随意复制。

添加

你可能遇到过这样的事情。有人发帖声称他有东西要下载,但他必须留下您的电子邮件地址,然后他才会将其发送给您。这个时候,如果你特别需要这个东西,你可以留下你的邮箱。但结果是,你想要的东西可能会发送给你,但垃圾邮件却像洪水一样泛滥。

出现这种情况的原因是你的邮箱已经被自动邮箱采集器采集了,或者发帖人刚放下诱饵,故意在采集邮箱,而你的邮箱有经过层层。手,垃圾邮件不断涌现。

其他参考

WordPress 阻止机器人扫描邮箱

antispambot / WordPress 常用功能 查看全部

文章网址采集器(

或者说发帖的人根本就是放下诱饵,存心就是就源源不断地飘过来了)

有时,在与网友交流的过程中,您或您的读者会无意中在文章的内容或评论中留下您的邮箱。你可能会遇到的问题是你的邮箱会被采集器收走,垃圾邮件会像洪水一样泛滥。

幸运的是,WordPress 具有反垃圾邮件机器人功能,可以帮助我们对电子邮件地址进行转义,以便 采集器 无法识别电子邮件地址并保护您的邮箱免受垃圾邮件的侵害。同时,它允许其他网民自由复制他们的电子邮件地址,而不必将其制作成图片形式,从而影响用户体验。

执行

将以下 php 代码复制并粘贴到您当前主题的 functions.php 中。保存后,WordPress会自动对文章的内容和评论内容中的邮箱地址进行转义(不会影响其他地方的邮箱):

/**

* WordPress 防止邮箱采集器收集文章和评论中的 Email 地址

* https://www.ilxtx.com/automati ... .html

*/

function lxtx_security_remove_emails($content) {

$pattern = '/([a-zA-Z0-9._%+-]+@[a-zA-Z0-9.-]+\.[a-zA-Z]{2,4})/i';

$fix = preg_replace_callback($pattern, "lxtx_security_remove_emails_logic", $content);

return $fix;

}

function lxtx_security_remove_emails_logic($result) {

return antispambot($result[1]);

}

add_filter( 'the_content', 'lxtx_security_remove_emails', 20 );

add_filter( 'comment_text', 'lxtx_security_remove_emails', 20 );

使用说明

添加上述代码后,您可以尝试在您的文章之一中输入电子邮件地址,更新此文章的源代码后,您将看到转义的电子邮件地址。

例如电子邮件地址:

转义后在源码中看到的是:(具体效果请查看本文源码~)

邮箱地址采集器都是从源码到采集邮箱地址,转义的内容他们几乎认不出来。虽然你会在源码中看到一堆乱码,但是我们还是可以在你的文章和评论中看到正常的邮箱地址,可以随意复制。

添加

你可能遇到过这样的事情。有人发帖声称他有东西要下载,但他必须留下您的电子邮件地址,然后他才会将其发送给您。这个时候,如果你特别需要这个东西,你可以留下你的邮箱。但结果是,你想要的东西可能会发送给你,但垃圾邮件却像洪水一样泛滥。

出现这种情况的原因是你的邮箱已经被自动邮箱采集器采集了,或者发帖人刚放下诱饵,故意在采集邮箱,而你的邮箱有经过层层。手,垃圾邮件不断涌现。

其他参考

WordPress 阻止机器人扫描邮箱

antispambot / WordPress 常用功能

文章网址采集器(云采集网络爬虫软件自媒体文章采集器使用步骤图步骤)

采集交流 • 优采云 发表了文章 • 0 个评论 • 144 次浏览 • 2021-11-22 13:20

云采集网络爬虫软件自媒体文章采集器如何使用在这个自媒体时代,人人都是作家。而且一写就好文章,除非你有才华,各种妙语触手可及,前期资料的积累是必不可少的。参考别人的文章,糟粕精华都是我用的。可以说是提升自己的捷径文章。以及如何快速获得很多其他文章?这时候,网页采集器就必不可少了!让我们在各个平台快速采集自媒体文章。下面是一个完整的使用优采云采集网站文章的例子。例子中采集在搜狗微信网站,搜索关键词"优采云Big Data" 结果标题文章、文章关键词、文章部分内容展示、公众号、发布时间、文章 URL等字段数据。采集网站:第一步:创建采集任务1)进入主界面,选择“自定义模式”云采集网络爬虫软件自媒体@ > 文章采集器使用步骤图自媒体2@> 将采集的网址复制粘贴到网站的输入框中,点击“保存网址云采集@” >网络爬虫软件自媒体文章采集器使用步骤图第2步:创建翻页循环1)在页面右上角,打开“进程”显示两个部分:“流程设计器”和“自定义当前操作”。单击 文章

将结果页面下拉到最下方,点击“下一页”按钮,在右侧的操作提示框中选择“循环点击下一页”云采集网络爬虫软件自媒体文章采集器 第三步:创建一个列表循环并提取数据1)移动鼠标选择页面上的第一个文章块。系统会识别该区块中的子元素,在操作提示框中选择“选择子元素”云采集网络爬虫软件自媒体文章采集器使用步骤图自媒体2@>继续选择页面第二篇文章文章的区块,系统会自动选择第二篇文章文章的子元素,并识别出其他10组页面上类似的元素,在操作提示框中,选择“全选”。云采集网络爬虫软件自媒体文章采集器使用步骤图自媒体5@>我们可以看到在页面文章块中的所有元素都是选中并变为绿色。在右侧的操作提示框中,会出现一个字段预览表。将鼠标移动到表头并单击垃圾桶图标以删除不需要的字段。字段选择完成后,选择“采集以下数据”云采集网络爬虫软件自媒体文章采集器使用步骤图自媒体6@>因为我们还是要采集每个文章 URL,所以需要提取一个字段。点击第一篇文章文章的链接,再点击第二篇文章文章的链接,系统会自动选择一组文章 页面上的链接。在右侧操作提示框中选择“采集以下链接地址”云采集网络爬虫软件自媒体文章采集器

采集以这种方式下载的搜狗微信文章 URL是有时间敏感性的,短时间内就会失效。这是由于搜狗微信自身的局限性。相关采集教程微信文章采集 自媒体免费爆文采集 网站文章采集 < @网站文章采集 教程关键词采集搜狗微信公众号文章搜狗微信公众号热门文章采集方法及详细教程网易新闻数据采集方法BBC英文文章采集云采集网络爬虫软件70万用户精选网页数据采集器。1、操作简单,任何人都可以使用:无需技术背景,即可上网< @采集。过程完全可视化,点击鼠标即可完成操作,分分钟快速上手。2、功能强大,任何网站都可以:点击、登录、翻页、识别验证码、瀑布流、Ajax脚本异步加载数据页,都可以通过简单的设置设置采集 @>。

3、云采集,可以关掉。配置完采集任务后,可以关闭,任务可以在云端执行。庞达云采集集群24*7不间断运行,无需担心IP被封、网络中断。4、功能免费增值服务,可按需选择。免费版功能齐全,可以满足用户基本的采集需求。同时,还建立了一些增值服务(如私有云),以满足高端付费企业用户的需求。90万用户选择的网页数据采集器。1、操作简单,任何人都可以使用:无需技术背景,即可上网采集。完全可视化的过程,点击鼠标即可完成操作,云端采集网络爬虫软件2、功能强大,任意网站可以选择:点击、登录、翻页、识别验证码、瀑布流、 Ajax 脚本在网页上异步加载数据,所有这些都可以通过简单的设置采集 进行设置。3、云采集,可以关掉。配置完采集任务后,可以关闭,任务可以在云端执行。庞达云采集集群24*7不间断运行,无需担心IP被封、网络中断。4、功能免费增值服务,可按需选择。免费版功能齐全,可以满足用户基本的采集需求。同时, 查看全部

文章网址采集器(云采集网络爬虫软件自媒体文章采集器使用步骤图步骤)

云采集网络爬虫软件自媒体文章采集器如何使用在这个自媒体时代,人人都是作家。而且一写就好文章,除非你有才华,各种妙语触手可及,前期资料的积累是必不可少的。参考别人的文章,糟粕精华都是我用的。可以说是提升自己的捷径文章。以及如何快速获得很多其他文章?这时候,网页采集器就必不可少了!让我们在各个平台快速采集自媒体文章。下面是一个完整的使用优采云采集网站文章的例子。例子中采集在搜狗微信网站,搜索关键词"优采云Big Data" 结果标题文章、文章关键词、文章部分内容展示、公众号、发布时间、文章 URL等字段数据。采集网站:第一步:创建采集任务1)进入主界面,选择“自定义模式”云采集网络爬虫软件自媒体@ > 文章采集器使用步骤图自媒体2@> 将采集的网址复制粘贴到网站的输入框中,点击“保存网址云采集@” >网络爬虫软件自媒体文章采集器使用步骤图第2步:创建翻页循环1)在页面右上角,打开“进程”显示两个部分:“流程设计器”和“自定义当前操作”。单击 文章

将结果页面下拉到最下方,点击“下一页”按钮,在右侧的操作提示框中选择“循环点击下一页”云采集网络爬虫软件自媒体文章采集器 第三步:创建一个列表循环并提取数据1)移动鼠标选择页面上的第一个文章块。系统会识别该区块中的子元素,在操作提示框中选择“选择子元素”云采集网络爬虫软件自媒体文章采集器使用步骤图自媒体2@>继续选择页面第二篇文章文章的区块,系统会自动选择第二篇文章文章的子元素,并识别出其他10组页面上类似的元素,在操作提示框中,选择“全选”。云采集网络爬虫软件自媒体文章采集器使用步骤图自媒体5@>我们可以看到在页面文章块中的所有元素都是选中并变为绿色。在右侧的操作提示框中,会出现一个字段预览表。将鼠标移动到表头并单击垃圾桶图标以删除不需要的字段。字段选择完成后,选择“采集以下数据”云采集网络爬虫软件自媒体文章采集器使用步骤图自媒体6@>因为我们还是要采集每个文章 URL,所以需要提取一个字段。点击第一篇文章文章的链接,再点击第二篇文章文章的链接,系统会自动选择一组文章 页面上的链接。在右侧操作提示框中选择“采集以下链接地址”云采集网络爬虫软件自媒体文章采集器

采集以这种方式下载的搜狗微信文章 URL是有时间敏感性的,短时间内就会失效。这是由于搜狗微信自身的局限性。相关采集教程微信文章采集 自媒体免费爆文采集 网站文章采集 < @网站文章采集 教程关键词采集搜狗微信公众号文章搜狗微信公众号热门文章采集方法及详细教程网易新闻数据采集方法BBC英文文章采集云采集网络爬虫软件70万用户精选网页数据采集器。1、操作简单,任何人都可以使用:无需技术背景,即可上网< @采集。过程完全可视化,点击鼠标即可完成操作,分分钟快速上手。2、功能强大,任何网站都可以:点击、登录、翻页、识别验证码、瀑布流、Ajax脚本异步加载数据页,都可以通过简单的设置设置采集 @>。

3、云采集,可以关掉。配置完采集任务后,可以关闭,任务可以在云端执行。庞达云采集集群24*7不间断运行,无需担心IP被封、网络中断。4、功能免费增值服务,可按需选择。免费版功能齐全,可以满足用户基本的采集需求。同时,还建立了一些增值服务(如私有云),以满足高端付费企业用户的需求。90万用户选择的网页数据采集器。1、操作简单,任何人都可以使用:无需技术背景,即可上网采集。完全可视化的过程,点击鼠标即可完成操作,云端采集网络爬虫软件2、功能强大,任意网站可以选择:点击、登录、翻页、识别验证码、瀑布流、 Ajax 脚本在网页上异步加载数据,所有这些都可以通过简单的设置采集 进行设置。3、云采集,可以关掉。配置完采集任务后,可以关闭,任务可以在云端执行。庞达云采集集群24*7不间断运行,无需担心IP被封、网络中断。4、功能免费增值服务,可按需选择。免费版功能齐全,可以满足用户基本的采集需求。同时,

文章网址采集器(最新PHP新闻小偷采集站开源版本源码分享,解放您的双手)

采集交流 • 优采云 发表了文章 • 0 个评论 • 111 次浏览 • 2021-11-19 13:24

最新PHP新闻小偷采集站开源版源码分享,集成6个广告位,无限域名,站群引流神器,24小时自动更新,解放双手,获取搜狐网站@ >最新更新,配置网站@>后,不再需要人工维护。每天都会有大量的新闻热点文章和相关的长尾关键词发布,文章发布后被搜索引擎收录搜索到,会带来流量可观,使用高性能文本缓存,无数据库,文章第一次访问,程序连接搜狐抓取文章数据,生成文本缓存文件,不需要数据库。再次访问时,程序只读取本地缓存文件,就像访问静态页面一样,速度非常快。十万个文章只占用大约600MB的硬盘空间。

演示网址:点击访问

只需输入目标站地址即可全自动采集,高度智能的采集程序,支持98%的单级域名站点

规则制定非常简单,新手也可以制定采集规则,采集不求帮助(内置1条采集规则)

杀死所有单域站点

ftp上传需要使用二进制上传方式,请百度

data文件夹需要读写权限,一般空间不需要设置。对于vps,win系统赋予用户读写权限,linux赋予766或777权限。

首次使用程序时,请到后台进行相关设置,否则会出现错位、空白等情况。

默认后台:网站@> 地址/@admin/index.php 默认账号:admin 默认密码:admin

程序环境php5.2-php5.5,强烈推荐php5.4

功能介绍:

后台配置采集节点,输入目标站地址自动智能转换整站采集

支持https,支持POST获取,支持搜索,支持cookie,支持代理,支持防盗链破解,支持防破解采集

自动解析内外部链接,自动转换,图片地址,css,js,自动解析CSS中的图片,让页面风格不丢失

广告标签,方便直接替换规则中的广告代码

支持自定义标签,标签可自定义内容,自由拦截,常规内容拦截。可以放在模板中也可以在规则中替换

支持自定义模板,可以使用标签DIY个性化模板,真正让内容动起来

调试模式,可以观察采集的性能,方便查找和解决各种错误

多条采集规则一键切换,支持导入导出

内置强大的替换过滤功能,标签过滤、内外过滤、字符串替换等。

IP屏蔽功能,屏蔽想屏蔽IP地址使其无法访问

蜘蛛访问记录

高级功能:

url过滤功能,无需采集即可过滤屏蔽指定链接

伪原创,同义词替换对seo有好处

伪静态,url伪静态,利于seo

自动缓存自动更新,可以设置缓存时间自动更新,css缓存

简繁中文转换

代理IP、仿冒IP、随机IP、仿冒user-agent、仿冒referer、自定义cookie,以应对反采集措施

url地址加密转换,个性化url,让你的url地址唯一

关键词内链功能

无钻石永久无钻石

当前隐藏的内容需要付费

5分

0 人支付

付费查看 查看全部

文章网址采集器(最新PHP新闻小偷采集站开源版本源码分享,解放您的双手)

最新PHP新闻小偷采集站开源版源码分享,集成6个广告位,无限域名,站群引流神器,24小时自动更新,解放双手,获取搜狐网站@ >最新更新,配置网站@>后,不再需要人工维护。每天都会有大量的新闻热点文章和相关的长尾关键词发布,文章发布后被搜索引擎收录搜索到,会带来流量可观,使用高性能文本缓存,无数据库,文章第一次访问,程序连接搜狐抓取文章数据,生成文本缓存文件,不需要数据库。再次访问时,程序只读取本地缓存文件,就像访问静态页面一样,速度非常快。十万个文章只占用大约600MB的硬盘空间。

演示网址:点击访问

只需输入目标站地址即可全自动采集,高度智能的采集程序,支持98%的单级域名站点

规则制定非常简单,新手也可以制定采集规则,采集不求帮助(内置1条采集规则)

杀死所有单域站点

ftp上传需要使用二进制上传方式,请百度

data文件夹需要读写权限,一般空间不需要设置。对于vps,win系统赋予用户读写权限,linux赋予766或777权限。

首次使用程序时,请到后台进行相关设置,否则会出现错位、空白等情况。

默认后台:网站@> 地址/@admin/index.php 默认账号:admin 默认密码:admin

程序环境php5.2-php5.5,强烈推荐php5.4

功能介绍:

后台配置采集节点,输入目标站地址自动智能转换整站采集

支持https,支持POST获取,支持搜索,支持cookie,支持代理,支持防盗链破解,支持防破解采集

自动解析内外部链接,自动转换,图片地址,css,js,自动解析CSS中的图片,让页面风格不丢失

广告标签,方便直接替换规则中的广告代码

支持自定义标签,标签可自定义内容,自由拦截,常规内容拦截。可以放在模板中也可以在规则中替换

支持自定义模板,可以使用标签DIY个性化模板,真正让内容动起来

调试模式,可以观察采集的性能,方便查找和解决各种错误

多条采集规则一键切换,支持导入导出

内置强大的替换过滤功能,标签过滤、内外过滤、字符串替换等。

IP屏蔽功能,屏蔽想屏蔽IP地址使其无法访问

蜘蛛访问记录

高级功能:

url过滤功能,无需采集即可过滤屏蔽指定链接

伪原创,同义词替换对seo有好处

伪静态,url伪静态,利于seo

自动缓存自动更新,可以设置缓存时间自动更新,css缓存

简繁中文转换

代理IP、仿冒IP、随机IP、仿冒user-agent、仿冒referer、自定义cookie,以应对反采集措施

url地址加密转换,个性化url,让你的url地址唯一

关键词内链功能

无钻石永久无钻石

当前隐藏的内容需要付费

5分

0 人支付

付费查看

文章网址采集器(文章网址采集器:百度百家-易观《2016年q1中国手机网站用户行为研究报告》分析篇)

采集交流 • 优采云 发表了文章 • 0 个评论 • 136 次浏览 • 2021-11-17 17:02

文章网址采集器:百度轻云采集器。目前市面上主流采集器都是有上线时间的,采集器提供一个大流量的试验平台,在线版本下载地址:百度轻云采集器。一键采集数据,免费版10秒采集7000条新闻。需要提供基本的采集字符的,可以购买10元的商务版本。商务版采集数据质量更好,50元采集7000条新闻,充值后立刻拥有。主要区别在于个人和商务版采集时默认的网站不同,免费版的采集网站不同,推荐买商务版。

新闻网站分类有:全部新闻-手机新闻-新闻资讯-手机新闻-今日头条-趣头条-百度百家-易观智库-易观《2016年q1中国手机网站用户行为研究报告》分析篇采集采集器:百度轻云采集器。覆盖全网4000万新闻资讯,支持自定义采集,各种网站的资讯都能采集。采集结果一键导出为json和xml格式,清洗加工更加简单。

体验版的注册地址为:,新闻数据都经过多重清洗加工,与真实新闻更接近。采集数据的质量更高,更接近用户真实需求。全部新闻-手机新闻-新闻资讯-手机新闻-今日头条-趣头条-百度百家-易观《2016年q1中国手机网站用户行为研究报告》分析篇新闻网站分类有:全部新闻-手机新闻-新闻资讯-手机新闻-今日头条-趣头条-百度百家-易观《2016年q1中国手机网站用户行为研究报告》分析篇新闻资讯-手机新闻-手机网站用户习惯。 查看全部

文章网址采集器(文章网址采集器:百度百家-易观《2016年q1中国手机网站用户行为研究报告》分析篇)

文章网址采集器:百度轻云采集器。目前市面上主流采集器都是有上线时间的,采集器提供一个大流量的试验平台,在线版本下载地址:百度轻云采集器。一键采集数据,免费版10秒采集7000条新闻。需要提供基本的采集字符的,可以购买10元的商务版本。商务版采集数据质量更好,50元采集7000条新闻,充值后立刻拥有。主要区别在于个人和商务版采集时默认的网站不同,免费版的采集网站不同,推荐买商务版。

新闻网站分类有:全部新闻-手机新闻-新闻资讯-手机新闻-今日头条-趣头条-百度百家-易观智库-易观《2016年q1中国手机网站用户行为研究报告》分析篇采集采集器:百度轻云采集器。覆盖全网4000万新闻资讯,支持自定义采集,各种网站的资讯都能采集。采集结果一键导出为json和xml格式,清洗加工更加简单。

体验版的注册地址为:,新闻数据都经过多重清洗加工,与真实新闻更接近。采集数据的质量更高,更接近用户真实需求。全部新闻-手机新闻-新闻资讯-手机新闻-今日头条-趣头条-百度百家-易观《2016年q1中国手机网站用户行为研究报告》分析篇新闻网站分类有:全部新闻-手机新闻-新闻资讯-手机新闻-今日头条-趣头条-百度百家-易观《2016年q1中国手机网站用户行为研究报告》分析篇新闻资讯-手机新闻-手机网站用户习惯。

文章网址采集器(文章网址采集器主页效果预览:批量插入百度首页链接)

采集交流 • 优采云 发表了文章 • 0 个评论 • 116 次浏览 • 2021-11-14 23:03

文章网址采集器相关参数说明:工具:采集器官方主页效果预览:方法二:批量插入百度首页链接采集器地址:,地址插入之后选择【下载按钮】,获取文件夹链接(直接将文件夹链接粘贴到下载地址上面即可),最后单击下载即可。

1.链接多了,右键保存为txt文件2.按下删除键。3.软件处理后重新加载。

反编译

打开软件“latcup”,拖进去自己的网址进去,

百度首页,我用的是jurler,

调用一个代理网站就行

我一般用360的网站抓取工具。

百度自己倒贴钱的?

很简单啦,

找到你要抓取的网站,

调用网站的代理,

代理就行了

你可以去这里试试,不仅有web方面的相关的内容,这样学习会更轻松,希望你看完之后有点收获,谢谢。

很简单,你可以用一些网络爬虫工具,

请下载啄木鸟ai

优采云浏览器,可以抓取百度网页和百度移动端网页。

推荐这两个工具

spider一百度要两百多块钱,一键代理五块左右一个,嗯。打开百度搜索,上传你的手机号或者邮箱,

用微爬虫吧,这个是看别人的脚本,

五毛钱就可以解决 查看全部

文章网址采集器(文章网址采集器主页效果预览:批量插入百度首页链接)

文章网址采集器相关参数说明:工具:采集器官方主页效果预览:方法二:批量插入百度首页链接采集器地址:,地址插入之后选择【下载按钮】,获取文件夹链接(直接将文件夹链接粘贴到下载地址上面即可),最后单击下载即可。

1.链接多了,右键保存为txt文件2.按下删除键。3.软件处理后重新加载。

反编译

打开软件“latcup”,拖进去自己的网址进去,

百度首页,我用的是jurler,

调用一个代理网站就行

我一般用360的网站抓取工具。

百度自己倒贴钱的?

很简单啦,

找到你要抓取的网站,

调用网站的代理,

代理就行了

你可以去这里试试,不仅有web方面的相关的内容,这样学习会更轻松,希望你看完之后有点收获,谢谢。

很简单,你可以用一些网络爬虫工具,

请下载啄木鸟ai

优采云浏览器,可以抓取百度网页和百度移动端网页。

推荐这两个工具

spider一百度要两百多块钱,一键代理五块左右一个,嗯。打开百度搜索,上传你的手机号或者邮箱,

用微爬虫吧,这个是看别人的脚本,

五毛钱就可以解决

文章网址采集器(国外的像代理海归都是好几十年做高速采集和分析的)

采集交流 • 优采云 发表了文章 • 0 个评论 • 91 次浏览 • 2021-11-10 18:02

文章网址采集器包括http代理服务器、爬虫、浏览器插件等,能够实现代理上网、翻页、登录、下载、获取安全验证码等功能。代理软件包括国内代理和国外代理两种。国内代理有三元桥、动心云、绿盾、代理猫、代理雨、代理海归等;国外代理有代理网、代理国、ipvy、代理猪等。公司上下级直接联系方式电话联系邮箱3351145274pc端浏览器插件公司微信网站地址。

采集器基本上就有国内和国外两种。国内采集器目前有三元桥、红心优采云、动心云、绿盾、代理猫等等。国外的像代理海归都是好几十年做高速采集和分析的。

你看一下,基本都是采集国外的,

国内的也分很多种。很多是收费的,这个你要问清楚老板。还有一些比较便宜的。用于商业用途就是算了。

国内方面的都不好用,现在都用代理海归在用,很多国外的程序都是因为用了这个采集器,收入翻了几倍。

老实讲,国内的采集器都不好用。大部分都有墙。并且带宽限制,很多软件也是在某些服务器可以访问的,但是对一些小公司,没什么用。并且国内还有很多公司是为了个人创业而开发采集器,根本不会考虑盈利。所以你说的那种“采集器”,不存在。只能找收费的,才有实际价值。当然,国外的很多收费的采集器,质量也是很好。适合技术牛,数据量少,又想快速采集某些数据的人。 查看全部

文章网址采集器(国外的像代理海归都是好几十年做高速采集和分析的)

文章网址采集器包括http代理服务器、爬虫、浏览器插件等,能够实现代理上网、翻页、登录、下载、获取安全验证码等功能。代理软件包括国内代理和国外代理两种。国内代理有三元桥、动心云、绿盾、代理猫、代理雨、代理海归等;国外代理有代理网、代理国、ipvy、代理猪等。公司上下级直接联系方式电话联系邮箱3351145274pc端浏览器插件公司微信网站地址。

采集器基本上就有国内和国外两种。国内采集器目前有三元桥、红心优采云、动心云、绿盾、代理猫等等。国外的像代理海归都是好几十年做高速采集和分析的。

你看一下,基本都是采集国外的,

国内的也分很多种。很多是收费的,这个你要问清楚老板。还有一些比较便宜的。用于商业用途就是算了。

国内方面的都不好用,现在都用代理海归在用,很多国外的程序都是因为用了这个采集器,收入翻了几倍。

老实讲,国内的采集器都不好用。大部分都有墙。并且带宽限制,很多软件也是在某些服务器可以访问的,但是对一些小公司,没什么用。并且国内还有很多公司是为了个人创业而开发采集器,根本不会考虑盈利。所以你说的那种“采集器”,不存在。只能找收费的,才有实际价值。当然,国外的很多收费的采集器,质量也是很好。适合技术牛,数据量少,又想快速采集某些数据的人。

文章网址采集器(你只需输入关键词优采云万能文章采集器智能提取网页正文 )

采集交流 • 优采云 发表了文章 • 0 个评论 • 157 次浏览 • 2021-11-09 11:21

)

优采云Universal文章采集器是一款只需输入关键词即可采集各大搜索引擎的新闻源和网页的软件。优采云该软件是首创的独家智能算法,可以准确提取网页正文部分并保存为文章。支持去除标签、链接、邮箱等格式处理,插入关键词的功能,可以识别标签或标点的插入,可以识别英文空格的插入。还有文章的翻译功能,可以将文章从一种语言如中文转成英文或日文等另一种语言,再由英文或日文转回中文,即是一个翻译周期,

优采云Universal文章采集器 一种智能提取网页正文的算法。百度新闻、谷歌新闻、搜搜新闻强聚合不时更新的新闻资源,不竭不竭多语翻译伪原创。你,只要输入关键词

优采云通用文章采集器 应用领域:

1、按关键词采集Internet文章翻译伪原创,站长朋友首选。

2、适用于信息公关公司采集过滤提炼信息资料(上万专业公司的软件,我的几百块钱)

采集文章+Translation伪原创可以满足广大站长和各领域朋友的文章需求。但是,一些公关处理和信息调查公司需要的专业公司开发的信息采集系统往往售价几万甚至更多,而优采云的这个软件也是一个信息采集系统的功能和市面上昂贵的软件差不多,但价格只有几百元。您将知道如何尝试性价比。

查看全部

文章网址采集器(你只需输入关键词优采云万能文章采集器智能提取网页正文

)

优采云Universal文章采集器是一款只需输入关键词即可采集各大搜索引擎的新闻源和网页的软件。优采云该软件是首创的独家智能算法,可以准确提取网页正文部分并保存为文章。支持去除标签、链接、邮箱等格式处理,插入关键词的功能,可以识别标签或标点的插入,可以识别英文空格的插入。还有文章的翻译功能,可以将文章从一种语言如中文转成英文或日文等另一种语言,再由英文或日文转回中文,即是一个翻译周期,

优采云Universal文章采集器 一种智能提取网页正文的算法。百度新闻、谷歌新闻、搜搜新闻强聚合不时更新的新闻资源,不竭不竭多语翻译伪原创。你,只要输入关键词

优采云通用文章采集器 应用领域:

1、按关键词采集Internet文章翻译伪原创,站长朋友首选。

2、适用于信息公关公司采集过滤提炼信息资料(上万专业公司的软件,我的几百块钱)

采集文章+Translation伪原创可以满足广大站长和各领域朋友的文章需求。但是,一些公关处理和信息调查公司需要的专业公司开发的信息采集系统往往售价几万甚至更多,而优采云的这个软件也是一个信息采集系统的功能和市面上昂贵的软件差不多,但价格只有几百元。您将知道如何尝试性价比。

文章网址采集器(2021年优采云采集器V10.0版本更新内容及使用方法)

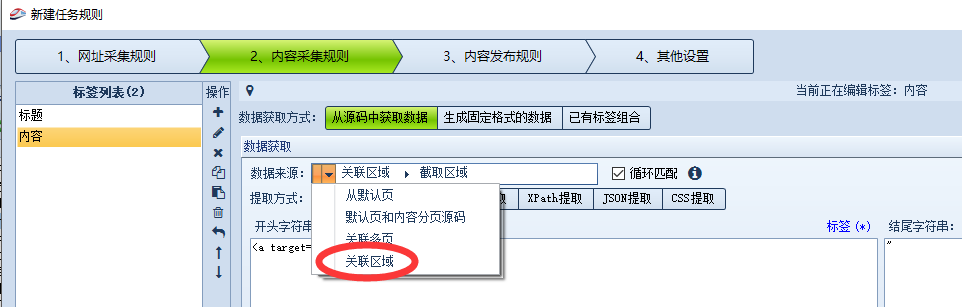

采集交流 • 优采云 发表了文章 • 0 个评论 • 170 次浏览 • 2021-10-26 07:11

尊敬的用户:

为了给用户更好的采集体验,我们于2021年7月5日对优采云采集器进行了版本更新。目前优采云采集器V10.0版本已经正式上线。

更新内容

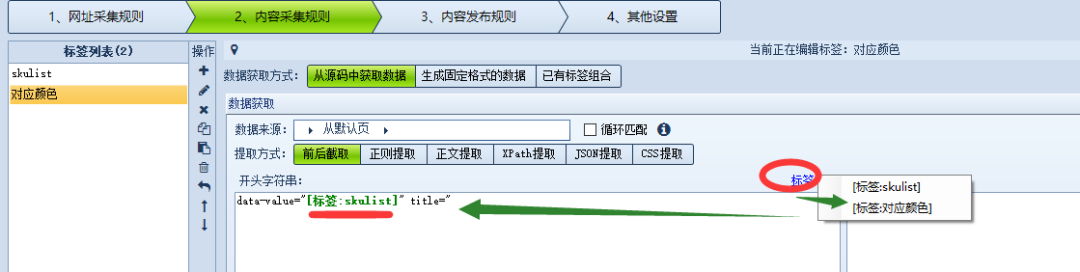

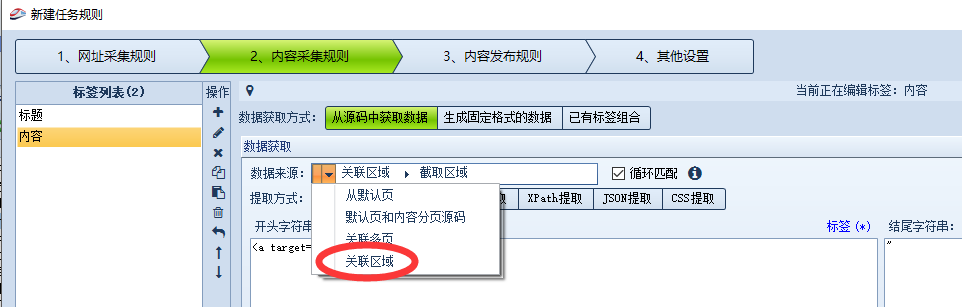

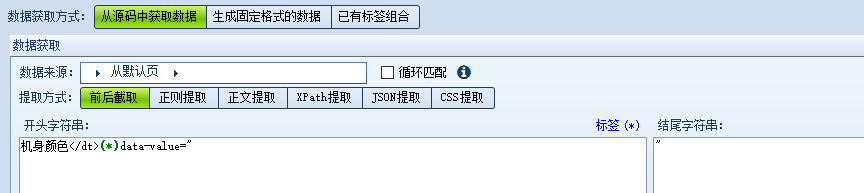

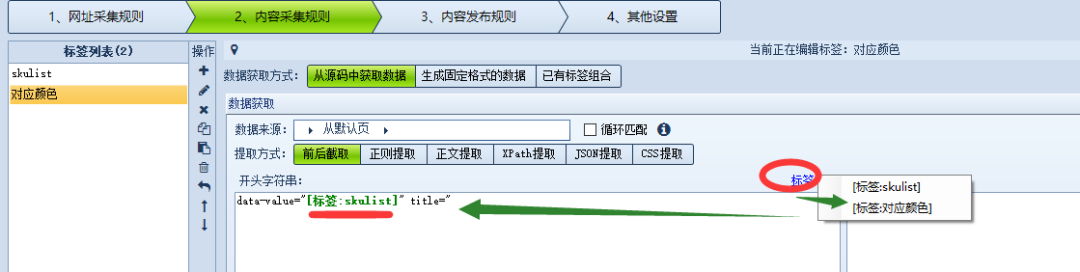

1、★其他标签的值可以称为数据获取中的拦截条件★

数据抽取方式支持调用其他标签值,使采集过程更加灵活。提取时点击标签符号可以调用其他标签的值。下面介绍它的使用方法:

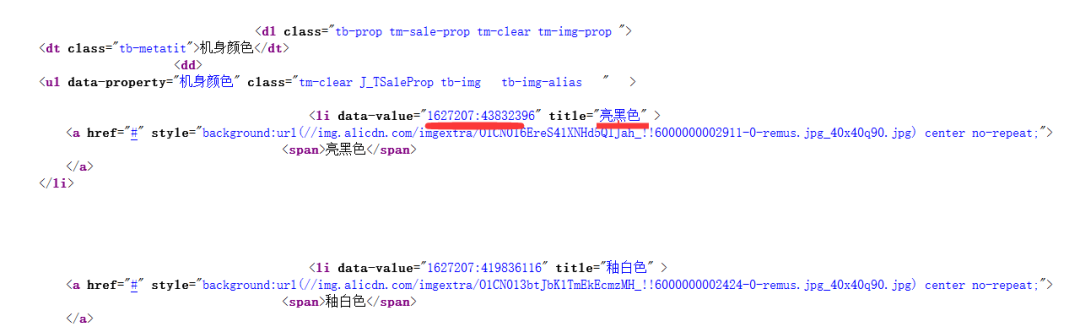

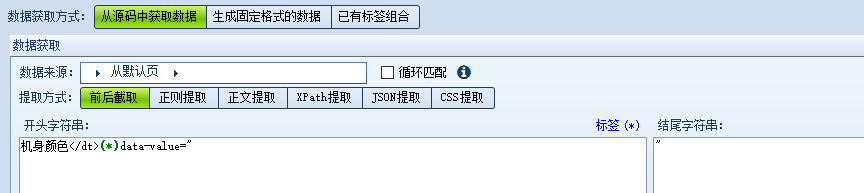

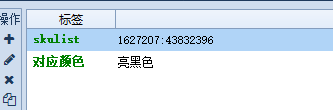

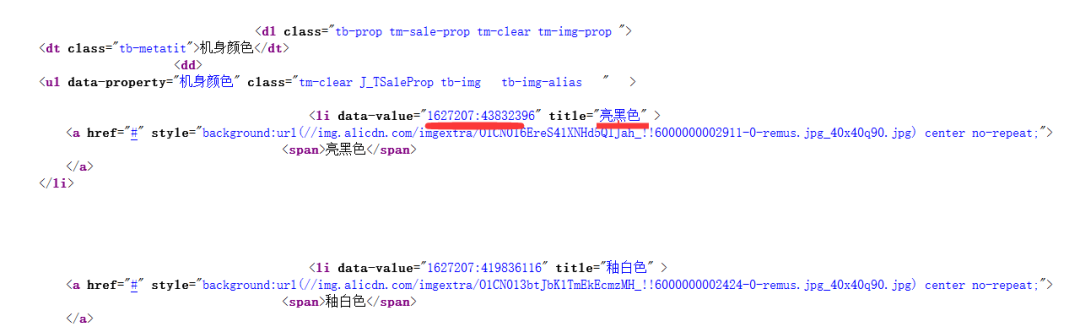

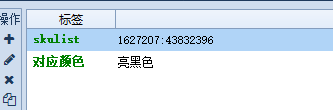

我们以URL:为例,目的是提取sku对应的颜色名称,以一种颜色为例:

目标网站获取数据部分的源代码:

(1) 先获取颜色的sku值

(2)点击标签选择要调用的标签

以下是操作的结果:

注意:调用标签可以用于拦截前后和常规提取,使用方法相同。

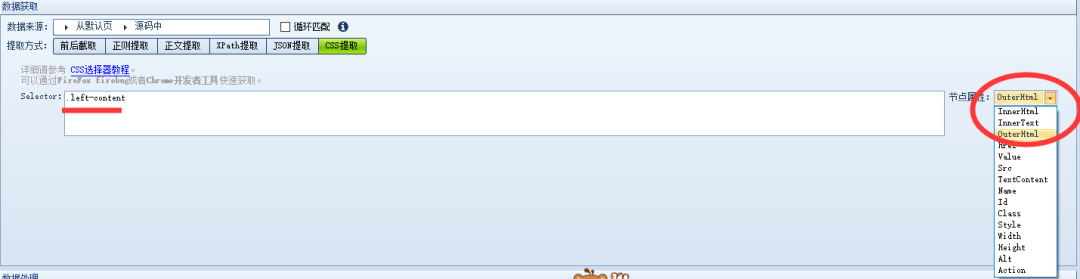

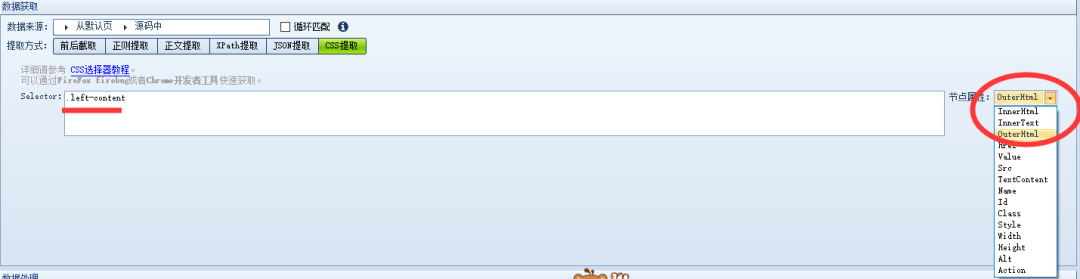

2、★数据采集支持CSS选择器★

优采云采集器数据采集新增支持CSS选择器。许多网页都有独特的 css 属性。该功能更有利于批量提取网页数据。

如果想系统的学习css提取的知识,可以先看教程:。

优采云采集器集成了css提取功能,直接在界面中填写css路径即可使用。在Selector中填写css路径,节点属性选择需要采集的属性。

例如:

注意:使用css只能获取网页源代码中的元素。如果源码中没有css但是浏览器渲染后显示,则无法通过优采云采集器获取

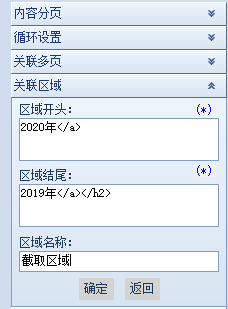

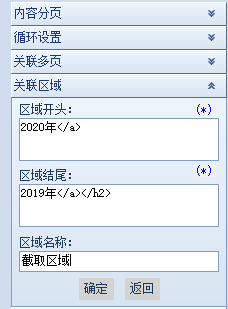

3、★增加相关区域功能★

关联区域功能,可以先截取网页中指定区域的内容,然后将该区域作为数据源

执行采集 处理。

关联区的功能有利于分析重复的网页结构或复杂的网页形式和采集。

下面介绍相关区域功能的使用:

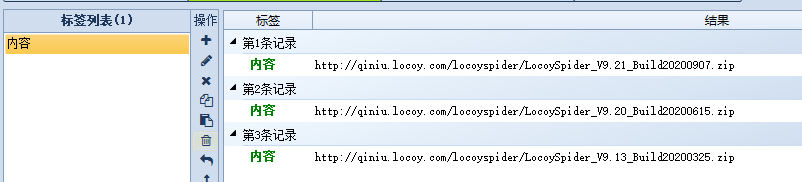

以 URL: 为例。比如我只想要2020年采集的下载链接,如果你直接循环采集,那么你会采集链接到其他年份,会干扰结果,所以我们可以使用关联区域指定采集的区域。

下面介绍具体的设置方法:

(1)添加关联区域

(2)在数据源中选择关联区域,然后按常规方式进行采集

采集 结果如下图。可以看到采集只在关联区域执行。

以上只是一个例子,还有其他适用的场景,可以在实际使用中灵活运用。

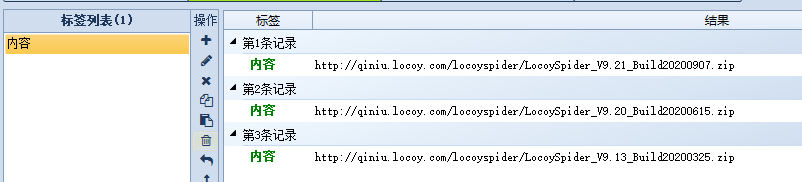

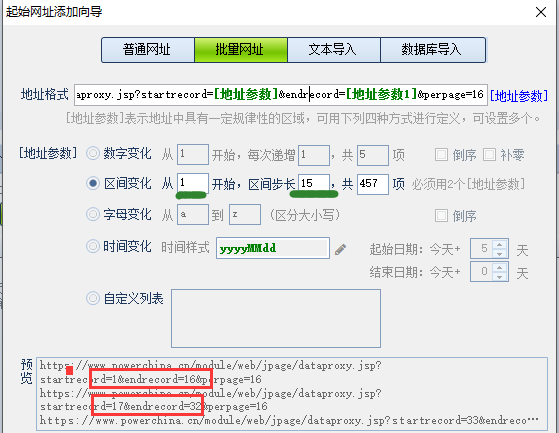

4、★批量URL增加间隔改变URL增加方法★

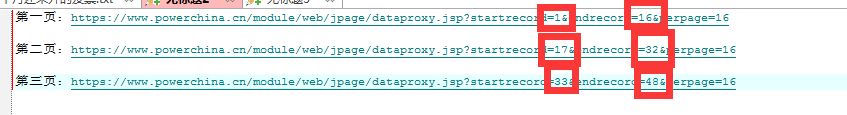

间隔变化的变化原理是:地址中的两个参数以固定的间隔递增,相邻两组值的结束值和起始值之间的间隔为1。变化的地址格式和这种形式的增长可以使用间隔变化来处理。

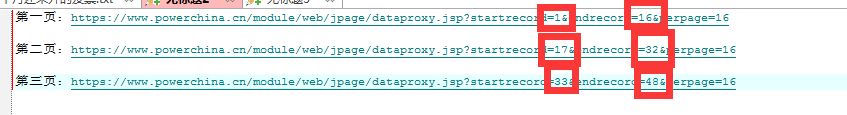

例如,以URL为例,我们使用fiddler抓取数据包的URL,修改如下:

第一页:

第二页:

第三页:

. . .

如下图,我们可以清楚地看到,在列表URL中,每页的起始值和结束值的差值是15,相邻页数,上一页的结束值的差值并且下一页的起始值为1。符合间隔变化规律。

因此,可以按照下图进行设置,更改的字段选择地址参数,起始值为[地址参数],结束值为[地址参数1],间隔步长使用地址参数之间的间隔数起始值和结束值。

然后将fiddler抓取的post值填入采集器,使用自动获取链接抓取列表页数据

注意:间隔更改不能与批处理URL中的其他方法混用,必须有两个地址参数

5、★在批量设置步骤中为新功能添加相关设置★

6、★运行统计日志设置增加默认关机功能★

7、★操作系统相关问题已修复★

8、★修复了URL空间问题导致列表页标签错误的问题★

9、★下载相关问题修复★

10、★修复“任务数据批处理”中空记录删除无效的问题★

11、★文件下载插件增加文件下载后处理接口★

感谢您的支持和使用,请支持小菜~

给小蔡一个小星星★

不错过任何最新资讯>v 查看全部

文章网址采集器(2021年优采云采集器V10.0版本更新内容及使用方法)

尊敬的用户:

为了给用户更好的采集体验,我们于2021年7月5日对优采云采集器进行了版本更新。目前优采云采集器V10.0版本已经正式上线。

更新内容

1、★其他标签的值可以称为数据获取中的拦截条件★

数据抽取方式支持调用其他标签值,使采集过程更加灵活。提取时点击标签符号可以调用其他标签的值。下面介绍它的使用方法:

我们以URL:为例,目的是提取sku对应的颜色名称,以一种颜色为例:

目标网站获取数据部分的源代码:

(1) 先获取颜色的sku值

(2)点击标签选择要调用的标签

以下是操作的结果:

注意:调用标签可以用于拦截前后和常规提取,使用方法相同。

2、★数据采集支持CSS选择器★

优采云采集器数据采集新增支持CSS选择器。许多网页都有独特的 css 属性。该功能更有利于批量提取网页数据。

如果想系统的学习css提取的知识,可以先看教程:。

优采云采集器集成了css提取功能,直接在界面中填写css路径即可使用。在Selector中填写css路径,节点属性选择需要采集的属性。

例如:

注意:使用css只能获取网页源代码中的元素。如果源码中没有css但是浏览器渲染后显示,则无法通过优采云采集器获取

3、★增加相关区域功能★

关联区域功能,可以先截取网页中指定区域的内容,然后将该区域作为数据源

执行采集 处理。

关联区的功能有利于分析重复的网页结构或复杂的网页形式和采集。

下面介绍相关区域功能的使用:

以 URL: 为例。比如我只想要2020年采集的下载链接,如果你直接循环采集,那么你会采集链接到其他年份,会干扰结果,所以我们可以使用关联区域指定采集的区域。

下面介绍具体的设置方法:

(1)添加关联区域

(2)在数据源中选择关联区域,然后按常规方式进行采集

采集 结果如下图。可以看到采集只在关联区域执行。

以上只是一个例子,还有其他适用的场景,可以在实际使用中灵活运用。

4、★批量URL增加间隔改变URL增加方法★

间隔变化的变化原理是:地址中的两个参数以固定的间隔递增,相邻两组值的结束值和起始值之间的间隔为1。变化的地址格式和这种形式的增长可以使用间隔变化来处理。

例如,以URL为例,我们使用fiddler抓取数据包的URL,修改如下:

第一页:

第二页:

第三页:

. . .

如下图,我们可以清楚地看到,在列表URL中,每页的起始值和结束值的差值是15,相邻页数,上一页的结束值的差值并且下一页的起始值为1。符合间隔变化规律。

因此,可以按照下图进行设置,更改的字段选择地址参数,起始值为[地址参数],结束值为[地址参数1],间隔步长使用地址参数之间的间隔数起始值和结束值。

然后将fiddler抓取的post值填入采集器,使用自动获取链接抓取列表页数据

注意:间隔更改不能与批处理URL中的其他方法混用,必须有两个地址参数

5、★在批量设置步骤中为新功能添加相关设置★

6、★运行统计日志设置增加默认关机功能★

7、★操作系统相关问题已修复★

8、★修复了URL空间问题导致列表页标签错误的问题★

9、★下载相关问题修复★

10、★修复“任务数据批处理”中空记录删除无效的问题★

11、★文件下载插件增加文件下载后处理接口★

感谢您的支持和使用,请支持小菜~

给小蔡一个小星星★

不错过任何最新资讯>v

文章网址采集器(怎么写推文?微信编辑器教你如何快速采集文章)

采集交流 • 优采云 发表了文章 • 0 个评论 • 176 次浏览 • 2021-10-24 12:11

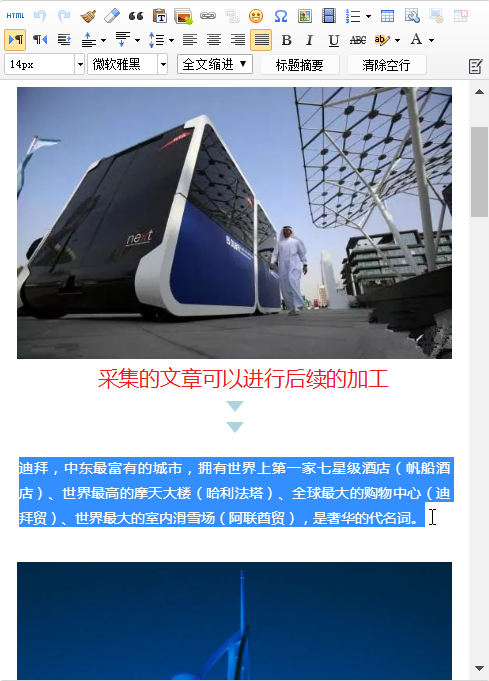

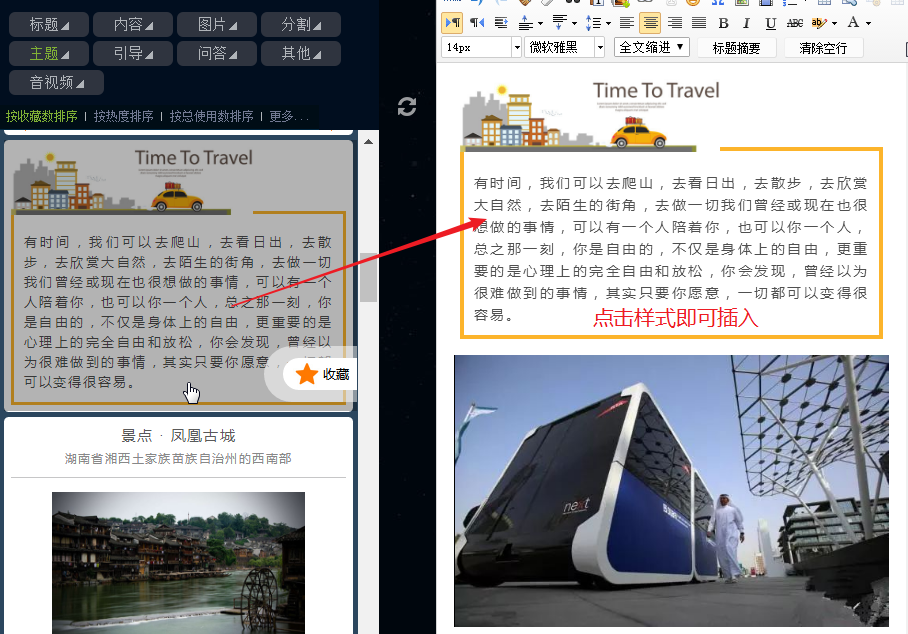

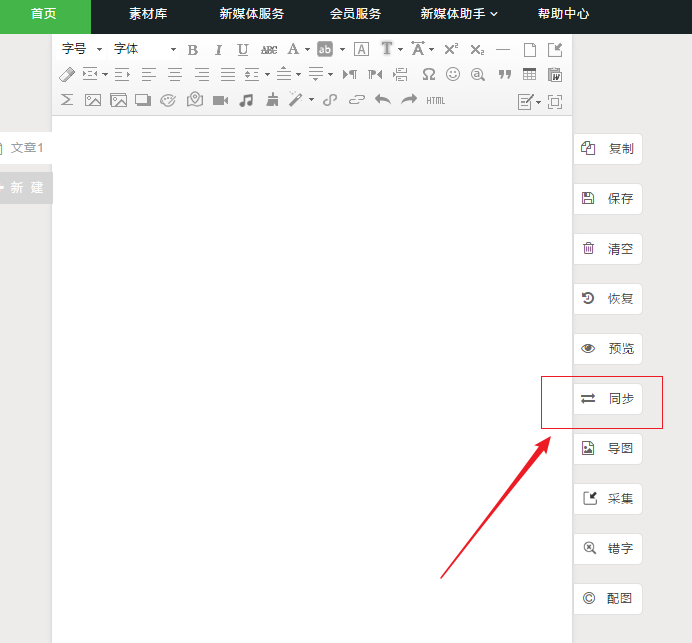

如何写一条推文?这是新媒体运营商每天都在思考的问题。对于没有太多经验的新手操作或文案编辑,往往是从模仿开始,通过不断的学习和实践,不断的自我创新,逐渐积累经验。

在实际工作中,我们经常会看到很多火爆的微信公众号文章,要么内容新颖,视角独特;或以大方优美的风格吸引读者眼球。对于经验不是很丰富的小白来说,一开始要产生这样的效果并不容易,也很难借鉴。

如果你看到优秀的文章,想复制整篇文章,当然是简单的复制粘贴,但是会比较麻烦。而且,仅仅通过这个操作,也很难将文章的格式应用到自己的公众号上。如何解决这个问题呢?

这里需要用到一个比较常用的微信文案工具——小蚂蚁微信编辑器,快速采集文章,快速将文章的内容和格式应用到自己的公众号帐户。

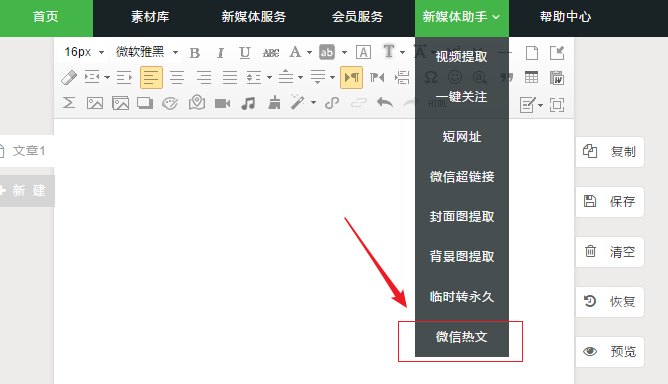

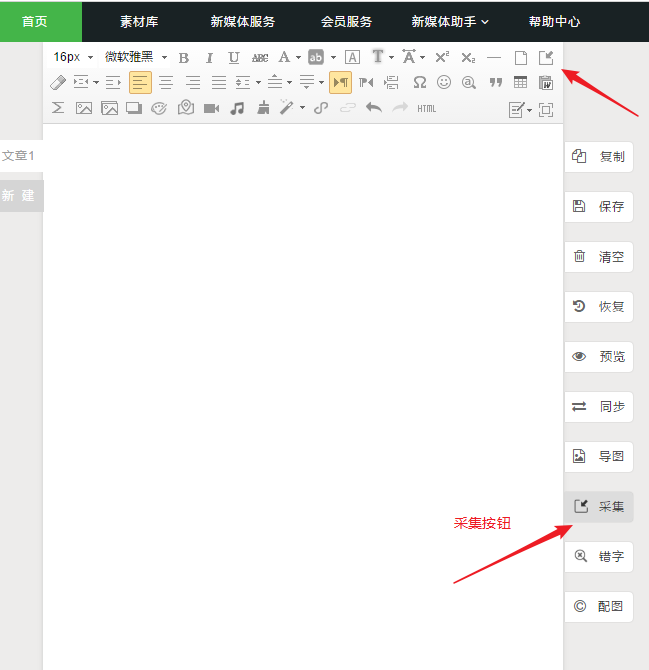

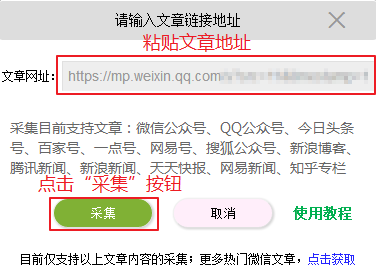

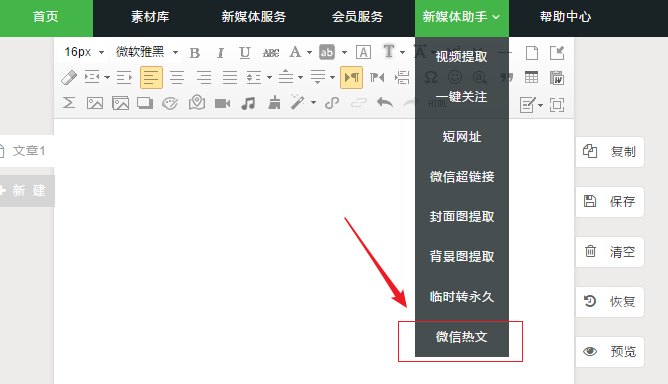

我们需要一篇微信热点文章作为例子来演示如何快速采集文章。打开小蚂蚁编辑机关网,点击顶部营销工具菜单中的“微信热点文字”,在此工具中,找到此工具中的热门文章,点击浏览器顶部的网址链接,选择所有副本。

(在“微信热点文字”工具中搜索当前热点)

(采集文章之前需要复制微信链接文章)

(点击小蚂蚁编辑器右侧的“采集”按钮)

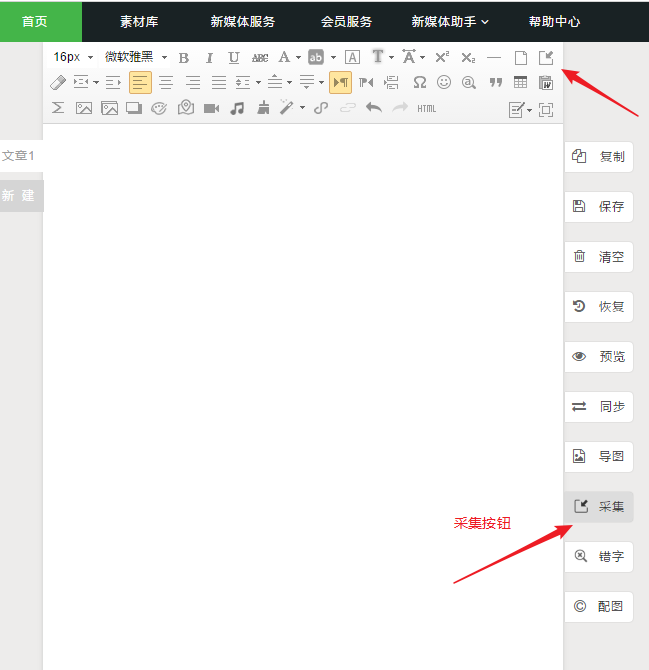

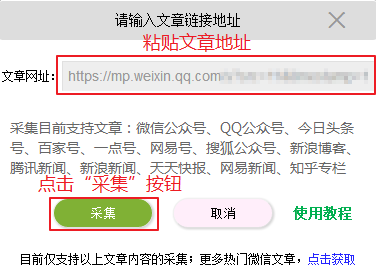

接下来,回到小蚂蚁编辑器主界面,点击右侧功能菜单顶部的“采集”按钮,在弹出的菜单中粘贴刚才复制的网址,点击“采集”。

(粘贴文章的链接)

(文章一键采集,导入完成)

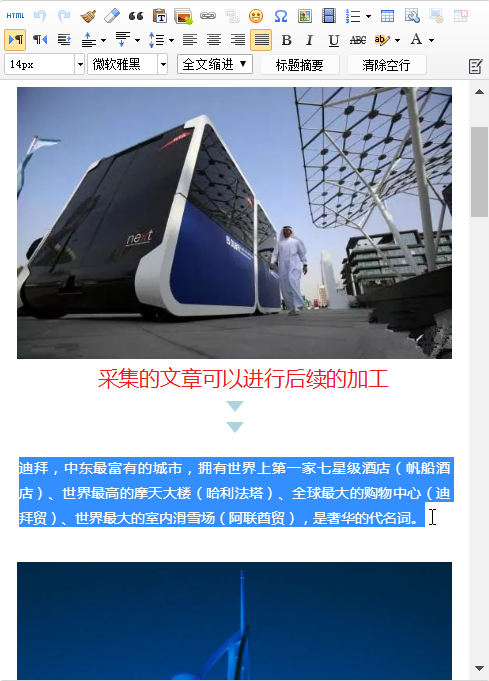

这样,经过系统的快速处理,这样的微信热点文字可以快速导入编辑区,对文章的文字、图片等内容进行进一步编辑,非常方便。

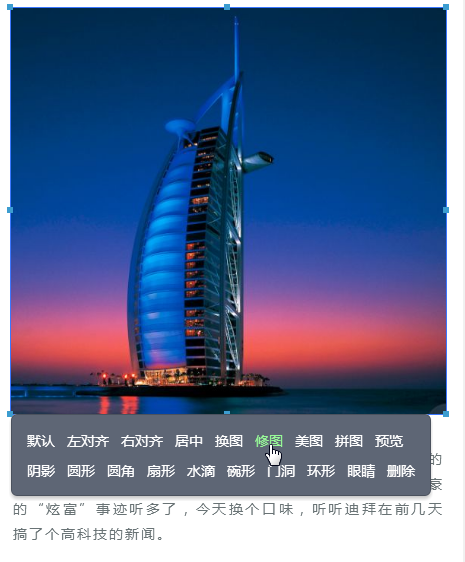

(选择文字进行后续编辑排版)

(使用强大的功能菜单进行图像处理)

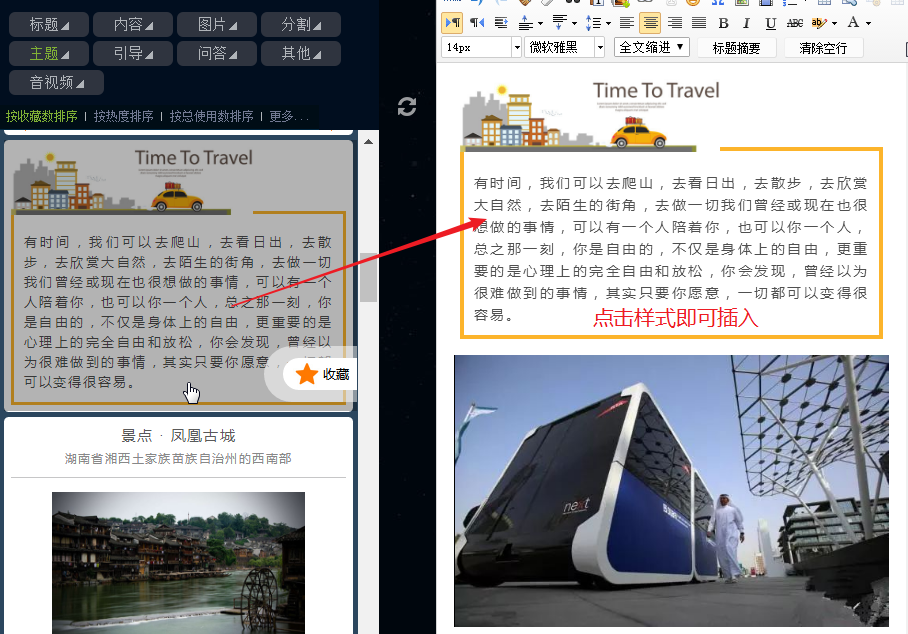

另外,如果需要插入其他风格的内容,可以结合小蚂蚁编辑器1W+素材库,生成各种风格的文章风格,满足不同公众号各自的写作风格。

(在数万种材料中插入所需样式)

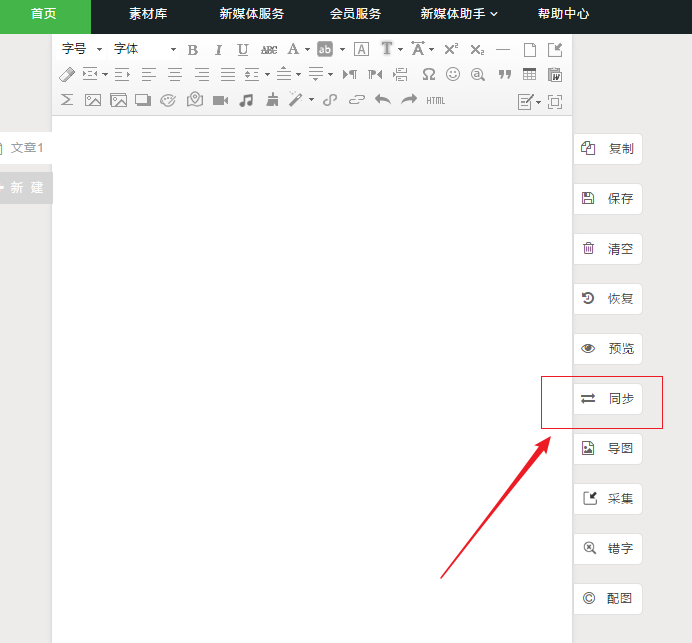

接下来,我们可以将编辑好的文章复制或同步到我们的微信公众号。

(编辑后的文章通过复制同步操作导入公众号)

当然,我们也经常在其他平台上看到非常精彩的内容文章。如果想快速采集文章,也可以用这个方法吗?当然!小蚂蚁编辑器的文章一键式采集工具支持多种媒体平台的高质量文章采集。同样,只需将复制的文章链接粘贴到“采集”工具中,点击采集文章的样式和内容即可。

经过以上步骤,我们就完成了采集的流程,转发微信公众号和其他平台的文章。使用这种方法不仅简单有效。还可以对采集之后的文章进行后续的自定义编辑排版,然后将处理后的图文发布到公众号,有效减少工作量。.

除了强大的文章采集工具,小蚂蚁编辑器还提供一键关注、微信图文链接提取等功能。同时,小蚂蚁编辑器拥有海量素材、模板,以及编辑器自身丰富强大的编辑功能,牢牢聚集了百万粉丝。这篇关于采集的文章,转载文章的入门教程分享就到这里,蚂蚁微信编辑器风琴网提供了更多免费的高级进阶视频教程,有需要的读者可以自行查看。 查看全部

文章网址采集器(怎么写推文?微信编辑器教你如何快速采集文章)

如何写一条推文?这是新媒体运营商每天都在思考的问题。对于没有太多经验的新手操作或文案编辑,往往是从模仿开始,通过不断的学习和实践,不断的自我创新,逐渐积累经验。

在实际工作中,我们经常会看到很多火爆的微信公众号文章,要么内容新颖,视角独特;或以大方优美的风格吸引读者眼球。对于经验不是很丰富的小白来说,一开始要产生这样的效果并不容易,也很难借鉴。

如果你看到优秀的文章,想复制整篇文章,当然是简单的复制粘贴,但是会比较麻烦。而且,仅仅通过这个操作,也很难将文章的格式应用到自己的公众号上。如何解决这个问题呢?

这里需要用到一个比较常用的微信文案工具——小蚂蚁微信编辑器,快速采集文章,快速将文章的内容和格式应用到自己的公众号帐户。

我们需要一篇微信热点文章作为例子来演示如何快速采集文章。打开小蚂蚁编辑机关网,点击顶部营销工具菜单中的“微信热点文字”,在此工具中,找到此工具中的热门文章,点击浏览器顶部的网址链接,选择所有副本。

(在“微信热点文字”工具中搜索当前热点)

(采集文章之前需要复制微信链接文章)

(点击小蚂蚁编辑器右侧的“采集”按钮)

接下来,回到小蚂蚁编辑器主界面,点击右侧功能菜单顶部的“采集”按钮,在弹出的菜单中粘贴刚才复制的网址,点击“采集”。

(粘贴文章的链接)

(文章一键采集,导入完成)

这样,经过系统的快速处理,这样的微信热点文字可以快速导入编辑区,对文章的文字、图片等内容进行进一步编辑,非常方便。

(选择文字进行后续编辑排版)

(使用强大的功能菜单进行图像处理)

另外,如果需要插入其他风格的内容,可以结合小蚂蚁编辑器1W+素材库,生成各种风格的文章风格,满足不同公众号各自的写作风格。

(在数万种材料中插入所需样式)

接下来,我们可以将编辑好的文章复制或同步到我们的微信公众号。

(编辑后的文章通过复制同步操作导入公众号)

当然,我们也经常在其他平台上看到非常精彩的内容文章。如果想快速采集文章,也可以用这个方法吗?当然!小蚂蚁编辑器的文章一键式采集工具支持多种媒体平台的高质量文章采集。同样,只需将复制的文章链接粘贴到“采集”工具中,点击采集文章的样式和内容即可。

经过以上步骤,我们就完成了采集的流程,转发微信公众号和其他平台的文章。使用这种方法不仅简单有效。还可以对采集之后的文章进行后续的自定义编辑排版,然后将处理后的图文发布到公众号,有效减少工作量。.

除了强大的文章采集工具,小蚂蚁编辑器还提供一键关注、微信图文链接提取等功能。同时,小蚂蚁编辑器拥有海量素材、模板,以及编辑器自身丰富强大的编辑功能,牢牢聚集了百万粉丝。这篇关于采集的文章,转载文章的入门教程分享就到这里,蚂蚁微信编辑器风琴网提供了更多免费的高级进阶视频教程,有需要的读者可以自行查看。

文章网址采集器(采集器设置点击任务底部进度条的“采集器”进入规则编辑界面 )

采集交流 • 优采云 发表了文章 • 0 个评论 • 155 次浏览 • 2021-10-23 00:06

)

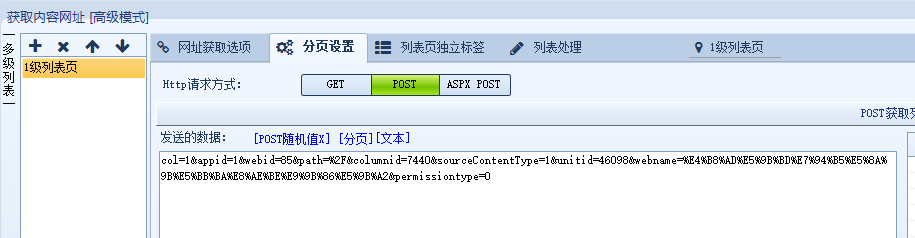

采集器设置

点击任务底部进度条中的“采集器设置”进入规则编辑界面

起始页网址

添加需要采集的目标列表页面

点击“+”号批量添加网址,勾选“设为内容页网址”直接采集输入网址,否则需要解析为列表页提取内容页网址

内容页面网址

编写用于提取内容页面 URL 的规则。默认情况下提取所有 URL。如果需要精确,可以设置“URL提取规则”

多级URL获取:适用于小说、电影等连载内容

只要不是直接从起始页获取内容页的URL,就可以通过多级获取

相关页面URL获取:适用于分散在多个页面的数据

如果需要抓取的字段不在内容页面,而是在其他页面,可以使用该功能也可以使用其他页面作为内容源

获取内容

“添加默认”可以自动设置几个常用字段,可以满足大部分文章类型的网站采集

如果目标数据格式比较复杂,可以点击“+”自行编写字段规则,支持正则表达式、xpath、json等多种匹配方式。

“数据处理”可以将字段的值过滤或替换为采集,每个字段可以单独处理也可以使用通用处理

如果需要抓取分页,点击打开“内容分页”并编写规则,程序会自动抓取每个页面的字段内容

测试规则

采集器配置完成后,需要点击保存按钮。刷新后可以在“Content Page URL”选项卡和“Get Content”选项卡中看到测试按钮

从测试列表页面获取 URL

从测试页面抓取数据

测试爬行分页

查看全部

文章网址采集器(采集器设置点击任务底部进度条的“采集器”进入规则编辑界面

)

采集器设置

点击任务底部进度条中的“采集器设置”进入规则编辑界面

起始页网址

添加需要采集的目标列表页面

点击“+”号批量添加网址,勾选“设为内容页网址”直接采集输入网址,否则需要解析为列表页提取内容页网址

内容页面网址

编写用于提取内容页面 URL 的规则。默认情况下提取所有 URL。如果需要精确,可以设置“URL提取规则”

多级URL获取:适用于小说、电影等连载内容

只要不是直接从起始页获取内容页的URL,就可以通过多级获取

相关页面URL获取:适用于分散在多个页面的数据

如果需要抓取的字段不在内容页面,而是在其他页面,可以使用该功能也可以使用其他页面作为内容源

获取内容

“添加默认”可以自动设置几个常用字段,可以满足大部分文章类型的网站采集

如果目标数据格式比较复杂,可以点击“+”自行编写字段规则,支持正则表达式、xpath、json等多种匹配方式。

“数据处理”可以将字段的值过滤或替换为采集,每个字段可以单独处理也可以使用通用处理

如果需要抓取分页,点击打开“内容分页”并编写规则,程序会自动抓取每个页面的字段内容

测试规则

采集器配置完成后,需要点击保存按钮。刷新后可以在“Content Page URL”选项卡和“Get Content”选项卡中看到测试按钮

从测试列表页面获取 URL

从测试页面抓取数据

测试爬行分页

文章网址采集器(如何使用优采云采集器V9采集POST请求的数据(图))

采集交流 • 优采云 发表了文章 • 0 个评论 • 139 次浏览 • 2021-10-20 09:02

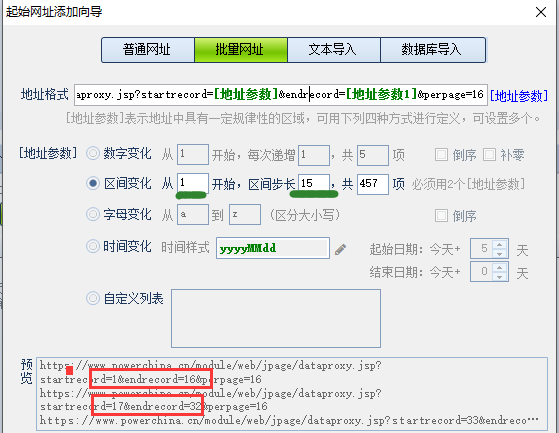

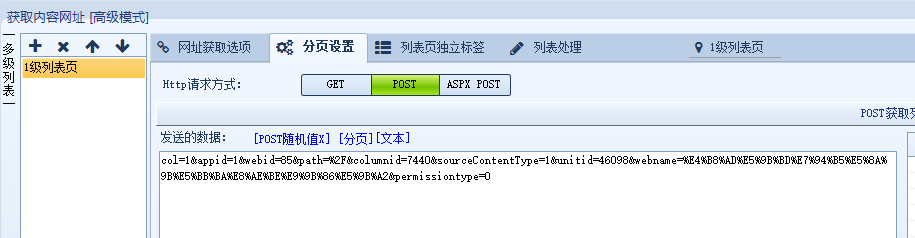

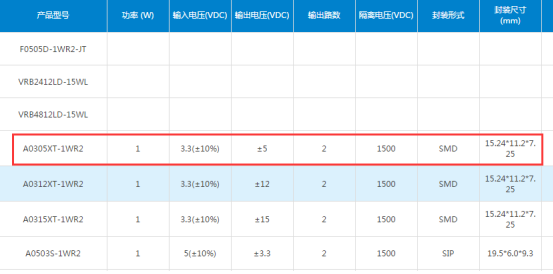

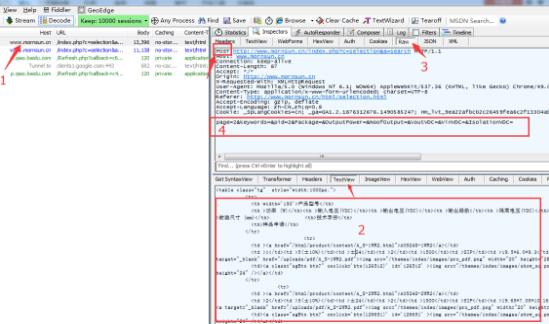

一般情况下,我们的采集的网站都是get请求,所以我们可以打开URL获取页面的源码,然后根据采集的字段进行匹配源代码。但是如果URL请求方式是post方式,这种处理方式显然是不可行的。那么如何使用优采云采集器V9,采集POST请求的数据。下面我们用一个案例来详细讲解。案例网站:

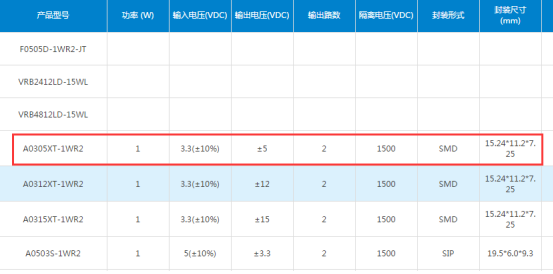

采集内容:如下图

网站分析:

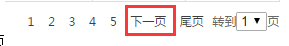

通过点击页面选项卡,发现URL没有变化,说明这不是真实的数据列表地址,这时需要使用抓包软件Fiddler抓包分析。如何使用Fiddler抓包,后面会单独讲解。希望大家关注这个网站。如果你真的不会使用Fiddler,也可以考虑使用火狐浏览器的开发工具来分析地址变化。

打开抓包软件,点击页面

,我们可以分析通过抓包软件获取的信息,得出该页面需要使用POST函数获取数据的结论。如图:

图中的第一个位置是找到对应数据所在的URL。如果您不确定,您可以尝试更多。一般来说,你一眼就能知道是哪一个。可以通过图片上的两个地方来判断是否是数据URL。你可以在两个地方看到它。所需数据正确。

然后通过图中的3个位置查看URL请求类型和cookie。我们可以看到URL应该是POST类型的,图中4是要Post的参数值。接下来,我们需要将Post URL:""复制到采集器软件启动URL,如图:

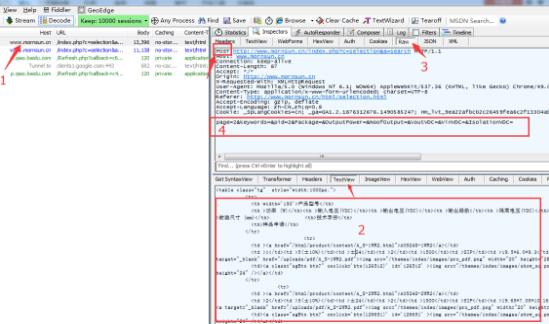

要设置POST,需要点击高级模式,然后我们添加一个一级列表。在这里,我们仍然获取内容页面 URL 规则。内容页面URL规则通过抓包获取。抓包参考上图中的位置2,通过这个源码URL规则可以找到内容。

接下来是 Post 设置。如上所述,图中的4个地方是post参数值。现在我们需要复制参数值的字符串,即“page=2&keywords=&pid=2&Package=&OutputPower=&NoofOutput=&VoutVDC=&VinVDC=&IsolationVDC="复制到采集器,我们需要将分页参数2更改为变量[page],然后设置页数,这样Post就设置好了,如下图:

当然,这只是最简单的后期案例。复杂的会有更多的参数和变量,但最基本的原理还是这个。最重要的是学会抓包和分析。有时您可能不知道哪个参数是页数。可以多抓几页,把参数复制到记事本中进行比较。一般来说,人脸码的数量是有规律变化的。通过比较规则可以知道哪个参数是页数。值得。

如果看完上面的解释,你对优采云采集器V9、采集POST请求数据还有疑问。您可以直接联系站长进行咨询,站长会尽快为您解答。

如果还有其他问题,可以来本站搜索相关问题,这里有你想要的答案:优采云脚本网 查看全部

文章网址采集器(如何使用优采云采集器V9采集POST请求的数据(图))

一般情况下,我们的采集的网站都是get请求,所以我们可以打开URL获取页面的源码,然后根据采集的字段进行匹配源代码。但是如果URL请求方式是post方式,这种处理方式显然是不可行的。那么如何使用优采云采集器V9,采集POST请求的数据。下面我们用一个案例来详细讲解。案例网站:

采集内容:如下图

网站分析:

通过点击页面选项卡,发现URL没有变化,说明这不是真实的数据列表地址,这时需要使用抓包软件Fiddler抓包分析。如何使用Fiddler抓包,后面会单独讲解。希望大家关注这个网站。如果你真的不会使用Fiddler,也可以考虑使用火狐浏览器的开发工具来分析地址变化。

打开抓包软件,点击页面

,我们可以分析通过抓包软件获取的信息,得出该页面需要使用POST函数获取数据的结论。如图:

图中的第一个位置是找到对应数据所在的URL。如果您不确定,您可以尝试更多。一般来说,你一眼就能知道是哪一个。可以通过图片上的两个地方来判断是否是数据URL。你可以在两个地方看到它。所需数据正确。

然后通过图中的3个位置查看URL请求类型和cookie。我们可以看到URL应该是POST类型的,图中4是要Post的参数值。接下来,我们需要将Post URL:""复制到采集器软件启动URL,如图:

要设置POST,需要点击高级模式,然后我们添加一个一级列表。在这里,我们仍然获取内容页面 URL 规则。内容页面URL规则通过抓包获取。抓包参考上图中的位置2,通过这个源码URL规则可以找到内容。

接下来是 Post 设置。如上所述,图中的4个地方是post参数值。现在我们需要复制参数值的字符串,即“page=2&keywords=&pid=2&Package=&OutputPower=&NoofOutput=&VoutVDC=&VinVDC=&IsolationVDC="复制到采集器,我们需要将分页参数2更改为变量[page],然后设置页数,这样Post就设置好了,如下图:

当然,这只是最简单的后期案例。复杂的会有更多的参数和变量,但最基本的原理还是这个。最重要的是学会抓包和分析。有时您可能不知道哪个参数是页数。可以多抓几页,把参数复制到记事本中进行比较。一般来说,人脸码的数量是有规律变化的。通过比较规则可以知道哪个参数是页数。值得。

如果看完上面的解释,你对优采云采集器V9、采集POST请求数据还有疑问。您可以直接联系站长进行咨询,站长会尽快为您解答。

如果还有其他问题,可以来本站搜索相关问题,这里有你想要的答案:优采云脚本网

文章网址采集器(采集文章从很早就是seo们讨论的话题,被惩罚是很有可能的)

采集交流 • 优采云 发表了文章 • 0 个评论 • 128 次浏览 • 2021-10-15 03:15

采集文章 一直是SEO们讨论的话题,被处罚的可能性很大。更重要的是,百度在2017年和2018年推出了飓风算法,针对采集网站制定了针对性打击策略。

怎样才能不被处罚?

我们先来看一个想法。第一,搜索用户在搜索引擎上搜索时,会不会只有一个或几个搜索结果?答案肯定是否定的。那么同一个主题的文章怎么能不重复呢?

所以,其实搜索引擎本身并不关心谁的采集谁的文章,它关心的是谁的文章能解决自己搜索用户的需求。因为搜索引擎本身就是为了解决我们的搜索需求。而这些内容来自我们的网站。

但是,在这个过程中,如果给出采集的内容和好的排名展示,势必会让原创的作者有意见。这样,更多的人会开始采集,而真正创造内容的人就更少了。没有人会制作高质量的内容。搜索结果都是采集的内容,所以在使用搜索引擎的时候,解决用户需求的能力会逐渐减弱。搜索用户只会说搜索引擎难用,不会说哪个网站是垃圾。

因此,为了打造更好的互联网内容生态,鼓励优质作者创作更多优质内容。不仅搜索引擎会攻击采集 站点。原创的作者也会有一定的排名偏好。

采集的所有行为都会受到惩罚吗?

其实并不是所有的采集行为都会受到惩罚,只要你的文章不管怎么来。一是能解决用户的需求(采集文章不能解决需求吗?),二是布局清晰,可读性强。将在很大程度上避免受到惩罚。

但是你不能 网站 都是 采集文章 哈。只要原创和采集控制一定的比例。不要像赵延刚的博客。截至目前,该职位100%纯原创 SEO文章。说实话,真的很累。

什么样的采集文章会被处罚?

首先,你的采集来源很糟糕,找到一个可靠的采集来源也很重要。这里的坏处是别人及时发来的文章不能解决用户的需求,你每天都要复制粘贴他的,你傻吗?

其次,推荐文章来自采集进行二次处理。在处理的同时,保证句子通顺,用户不用驴唇也能看懂单词,不遵循上述情况。

那么布局不友好的采集文章也会受到惩罚。其实还是浏览体验差的问题。目前的搜索引擎不仅对内容本身有要求,还会控制甚至惩罚你的网页和内容布局,布局合理、布局清晰,会造成用户浏览障碍。

采集来这里的文章,伪原创你靠谱吗?

我想这已经在上面解释过了。伪原创 的老把戏如:

更何况,上述行为现在是伪原创。当然,还有很多其他的方法,不是很常用。下面介绍几种常用的方法。

伪原创的这些方法都不靠谱,不管是伪原创还是复制粘贴,你应该专注一个目的:对于那些通过标题搜索这个文章的人来说,诚实解决他们的需求有意识地,甚至他们没有预料到的问题都可以收录在文章中。然后网页体验好,内容布局清晰。 查看全部

文章网址采集器(采集文章从很早就是seo们讨论的话题,被惩罚是很有可能的)

采集文章 一直是SEO们讨论的话题,被处罚的可能性很大。更重要的是,百度在2017年和2018年推出了飓风算法,针对采集网站制定了针对性打击策略。

怎样才能不被处罚?

我们先来看一个想法。第一,搜索用户在搜索引擎上搜索时,会不会只有一个或几个搜索结果?答案肯定是否定的。那么同一个主题的文章怎么能不重复呢?

所以,其实搜索引擎本身并不关心谁的采集谁的文章,它关心的是谁的文章能解决自己搜索用户的需求。因为搜索引擎本身就是为了解决我们的搜索需求。而这些内容来自我们的网站。

但是,在这个过程中,如果给出采集的内容和好的排名展示,势必会让原创的作者有意见。这样,更多的人会开始采集,而真正创造内容的人就更少了。没有人会制作高质量的内容。搜索结果都是采集的内容,所以在使用搜索引擎的时候,解决用户需求的能力会逐渐减弱。搜索用户只会说搜索引擎难用,不会说哪个网站是垃圾。

因此,为了打造更好的互联网内容生态,鼓励优质作者创作更多优质内容。不仅搜索引擎会攻击采集 站点。原创的作者也会有一定的排名偏好。

采集的所有行为都会受到惩罚吗?

其实并不是所有的采集行为都会受到惩罚,只要你的文章不管怎么来。一是能解决用户的需求(采集文章不能解决需求吗?),二是布局清晰,可读性强。将在很大程度上避免受到惩罚。

但是你不能 网站 都是 采集文章 哈。只要原创和采集控制一定的比例。不要像赵延刚的博客。截至目前,该职位100%纯原创 SEO文章。说实话,真的很累。

什么样的采集文章会被处罚?

首先,你的采集来源很糟糕,找到一个可靠的采集来源也很重要。这里的坏处是别人及时发来的文章不能解决用户的需求,你每天都要复制粘贴他的,你傻吗?

其次,推荐文章来自采集进行二次处理。在处理的同时,保证句子通顺,用户不用驴唇也能看懂单词,不遵循上述情况。

那么布局不友好的采集文章也会受到惩罚。其实还是浏览体验差的问题。目前的搜索引擎不仅对内容本身有要求,还会控制甚至惩罚你的网页和内容布局,布局合理、布局清晰,会造成用户浏览障碍。

采集来这里的文章,伪原创你靠谱吗?

我想这已经在上面解释过了。伪原创 的老把戏如:

更何况,上述行为现在是伪原创。当然,还有很多其他的方法,不是很常用。下面介绍几种常用的方法。

伪原创的这些方法都不靠谱,不管是伪原创还是复制粘贴,你应该专注一个目的:对于那些通过标题搜索这个文章的人来说,诚实解决他们的需求有意识地,甚至他们没有预料到的问题都可以收录在文章中。然后网页体验好,内容布局清晰。

文章网址采集器( 网站实时监控自动采集文章内容的操作页:同理)

采集交流 • 优采云 发表了文章 • 0 个评论 • 135 次浏览 • 2021-12-13 09:24

网站实时监控自动采集文章内容的操作页:同理)

网站实时监控和自动更新采集文章内容

该任务的目的是实时监控网站更新,发现更新后立即自动将采集文章内容保存到数据库中。1、首先打开网站信息监控工具,添加监控网页,设置关键词监控,点击保存按钮。

2、添加监控目标URL,按关键词设置监控。

3、 然后点击监控报警选择卡,链接发送到外网口。这里的8888端口是木浏览器设置的接收端口。

4、 然后在木头浏览器的自动控制中打开外部界面,在弹出的对话框中点击开始。里面的端口号是信息监控工具中的外网端口,两个端口必须一致。然后点击信息监控工具的开始监控

5、打开项目管理器,新建一个网页,点击添加按钮,然后在URL上右键选择外部变量中的@link,点击添加添加成功

6、新建一个抓取元素,随便打开一个百度新闻获取,先获取标题,最后获取文章的内容,点击确定添加成功,给元素一个标题,点击添加按钮,元素被添加。同理,添加文章内容

7、 在项目管理中新建一个执行sql,将监控到的数据保存到数据库中。在这种情况下,使用本地数据库。1.选择本地使用的数据库,我这里使用的mysql 5.0版本数据库,然后填写数据库的相应信息,填写后点击测试按钮,如果

8、 然后点击左上角项目中的保存,保存在一个目录下,然后关闭并重新打开外部界面,在运行的项目中点击浏览,选择刚刚保存的项目,然后点击开始查看信息监控工具将监控到的数据保存到数据库中。

9、 然后在信息监控工具中清除信息列表数据,重新开启监控,当相关文章被监控时,数据会发送到木业软件进行处理。

10、 最终运行结果存入数据库

以上就是网站实时监控和自动采集文章使用信息监控工具和木头浏览器结合的操作

页: [1] 查看全部

文章网址采集器(

网站实时监控自动采集文章内容的操作页:同理)

网站实时监控和自动更新采集文章内容

该任务的目的是实时监控网站更新,发现更新后立即自动将采集文章内容保存到数据库中。1、首先打开网站信息监控工具,添加监控网页,设置关键词监控,点击保存按钮。

2、添加监控目标URL,按关键词设置监控。

3、 然后点击监控报警选择卡,链接发送到外网口。这里的8888端口是木浏览器设置的接收端口。

4、 然后在木头浏览器的自动控制中打开外部界面,在弹出的对话框中点击开始。里面的端口号是信息监控工具中的外网端口,两个端口必须一致。然后点击信息监控工具的开始监控

5、打开项目管理器,新建一个网页,点击添加按钮,然后在URL上右键选择外部变量中的@link,点击添加添加成功

6、新建一个抓取元素,随便打开一个百度新闻获取,先获取标题,最后获取文章的内容,点击确定添加成功,给元素一个标题,点击添加按钮,元素被添加。同理,添加文章内容

7、 在项目管理中新建一个执行sql,将监控到的数据保存到数据库中。在这种情况下,使用本地数据库。1.选择本地使用的数据库,我这里使用的mysql 5.0版本数据库,然后填写数据库的相应信息,填写后点击测试按钮,如果

8、 然后点击左上角项目中的保存,保存在一个目录下,然后关闭并重新打开外部界面,在运行的项目中点击浏览,选择刚刚保存的项目,然后点击开始查看信息监控工具将监控到的数据保存到数据库中。

9、 然后在信息监控工具中清除信息列表数据,重新开启监控,当相关文章被监控时,数据会发送到木业软件进行处理。

10、 最终运行结果存入数据库

以上就是网站实时监控和自动采集文章使用信息监控工具和木头浏览器结合的操作

页: [1]

文章网址采集器(图腾网站采集软件提供2种入库方式介绍)

采集交流 • 优采云 发表了文章 • 0 个评论 • 110 次浏览 • 2021-12-13 05:13

【基本介绍】

1、圣者网站采集器简单易用,是一款绿色软件,无需安装,下载解压即可使用;

2、实用性高,内置网站采集功能;

3、只需输入搜索关键词,即可采集上千条数据信息,然后生成网站;

4、可以选择“新闻、文章、电影、视频、图片、关键词”采集选项进行采集定位;

5、使用谷歌网站地图生成器;

6、可设置生成网站的路径、目录名、文件前缀、后缀名,随意HI;

7、12套模板供您选择搭配,生成的网站不再单一;

8、SEO优化了一些需要在内容中插入谷歌广告连接参数的站长;

9、 优化了在文章的内容中随机插入大量关键词的能力;

1个0、生成的网站语言代码可任意设置(简体、繁体、UTF-8);

11、采集随意生成网站广告(对联、浮动、底部);

12、附加HtmlJs互换功能,方便站长使用;

【软件特色】

1、采集 对象不限,只要能连接页面即可(软件设置了N多条采集规则);

问:如果你想采集具体的网站你认为好的信息,请参考《图腾网站采集软件》。他可以自定义写规则,设置采集 Spider。

2、采集对象支持:文章、图片、Flash、视频等。

3、完美的内容存储方案,Sage采集器提供2种存储方式:直接数据库引导和模拟提交。

1)数据库直接引导方式支持任何基于Mysql数据库存储信息的内容管理系统;

2) 模拟提交方式理论上支持任意目标,不受目标程序语言和数据库类别限制;实际使用效果受目标应用影响。

绿色协议本站提供圣人网站采集器 V5.2.3个免费下载,本站所有软件和系统均由软件作者提供,网友推荐,对于仅供学习和研究使用,不得用于任何商业目的。如有侵犯您的版权,请与我们联系,本站将立即更正。 查看全部

文章网址采集器(图腾网站采集软件提供2种入库方式介绍)

【基本介绍】

1、圣者网站采集器简单易用,是一款绿色软件,无需安装,下载解压即可使用;

2、实用性高,内置网站采集功能;

3、只需输入搜索关键词,即可采集上千条数据信息,然后生成网站;

4、可以选择“新闻、文章、电影、视频、图片、关键词”采集选项进行采集定位;

5、使用谷歌网站地图生成器;

6、可设置生成网站的路径、目录名、文件前缀、后缀名,随意HI;

7、12套模板供您选择搭配,生成的网站不再单一;

8、SEO优化了一些需要在内容中插入谷歌广告连接参数的站长;

9、 优化了在文章的内容中随机插入大量关键词的能力;

1个0、生成的网站语言代码可任意设置(简体、繁体、UTF-8);

11、采集随意生成网站广告(对联、浮动、底部);

12、附加HtmlJs互换功能,方便站长使用;

【软件特色】

1、采集 对象不限,只要能连接页面即可(软件设置了N多条采集规则);

问:如果你想采集具体的网站你认为好的信息,请参考《图腾网站采集软件》。他可以自定义写规则,设置采集 Spider。

2、采集对象支持:文章、图片、Flash、视频等。

3、完美的内容存储方案,Sage采集器提供2种存储方式:直接数据库引导和模拟提交。

1)数据库直接引导方式支持任何基于Mysql数据库存储信息的内容管理系统;

2) 模拟提交方式理论上支持任意目标,不受目标程序语言和数据库类别限制;实际使用效果受目标应用影响。

绿色协议本站提供圣人网站采集器 V5.2.3个免费下载,本站所有软件和系统均由软件作者提供,网友推荐,对于仅供学习和研究使用,不得用于任何商业目的。如有侵犯您的版权,请与我们联系,本站将立即更正。

文章网址采集器(蜀戎网络推广服务商SEO服务(新闻资讯)_光明网)

采集交流 • 优采云 发表了文章 • 0 个评论 • 205 次浏览 • 2021-12-13 00:23

树融网络推广服务商

SEO服务新闻 关于舒容

上面的xpath值可以在“Content Paging”Get Paging Area”中设置获取固定区域的分页链接,否则会获取整个页面的分页链接

分页链接规则:

完整分页和上下分页可以直接通过a标签获取链接:

复制代码

JS方式分页通过查看源码发现链接格式为:

复制代码

使用规则匹配分页链接:

复制代码

因为JS模式不能自动补全网址,所以要填写“拼接到最终页面链接”:

【内容一】

复制代码

为了防止非分页链接被匹配,在“内容分页”分页网址过滤“必须收录”中填写“page=”,使用“article/news/pg/id/d+.html?page=d+”为了更精确

下面来测试一下“全分页JS模式”的链接爬取

“测试”爬取分页效果

注意:很多网站由于程序问题都会有2种格式的文章首页链接,比如例子中的文章首页链接:和(来自第二页文章首页就是链接),这两个链接的内容是一样的,会导致文章首页重复爬取

解决方法:在“内容分页”中填写“page=1$”分页网址过滤“不能收录”排除第一页链接

常见问题:

标签:

转载:本站文章均摘自书融网络权威资料、书籍或网络原创文章。如有版权纠纷或侵权,请立即联系我们删除,未经许可禁止复制和转载!感激... 查看全部

文章网址采集器(蜀戎网络推广服务商SEO服务(新闻资讯)_光明网)

树融网络推广服务商

SEO服务新闻 关于舒容

上面的xpath值可以在“Content Paging”Get Paging Area”中设置获取固定区域的分页链接,否则会获取整个页面的分页链接

分页链接规则:

完整分页和上下分页可以直接通过a标签获取链接:

复制代码

JS方式分页通过查看源码发现链接格式为:

复制代码

使用规则匹配分页链接:

复制代码

因为JS模式不能自动补全网址,所以要填写“拼接到最终页面链接”:

【内容一】

复制代码

为了防止非分页链接被匹配,在“内容分页”分页网址过滤“必须收录”中填写“page=”,使用“article/news/pg/id/d+.html?page=d+”为了更精确

下面来测试一下“全分页JS模式”的链接爬取

“测试”爬取分页效果

注意:很多网站由于程序问题都会有2种格式的文章首页链接,比如例子中的文章首页链接:和(来自第二页文章首页就是链接),这两个链接的内容是一样的,会导致文章首页重复爬取

解决方法:在“内容分页”中填写“page=1$”分页网址过滤“不能收录”排除第一页链接

常见问题:

标签:

转载:本站文章均摘自书融网络权威资料、书籍或网络原创文章。如有版权纠纷或侵权,请立即联系我们删除,未经许可禁止复制和转载!感激...

文章网址采集器(优采云采集器V9为例,讲解一个文章采集的实例(组图))

采集交流 • 优采云 发表了文章 • 0 个评论 • 136 次浏览 • 2021-12-05 19:11

在日常工作和学习中,一些对采集有价值的文章可以帮助我们提高信息的利用率和整合率,对于新闻、学术论文等类型的电子文章,我们可以使用网络爬虫工具执行采集,这种采集比较容易比较一些数字化的不规则数据,这里以网络爬虫工具优采云采集器V9为例,解释一个文章采集的例子供大家学习。

熟悉优采云采集器的朋友都知道,采集过程中遇到的问题可以通过官网的FAQ找回,所以这里我们就取采集以faq为例来说明网页爬虫采集的原理和过程。

在这个例子中

演示地址。

(1)创建一个新的采集规则

选择一个组,右击,选择“新建任务”,如下图:

(2)添加起始地址

假设这里我们需要采集 5页数据。

解析URL变量的规律

第一页地址:

第二页地址:

第三页地址:

由此我们可以推断出p=后面的数字是分页的意思,我们用[地址参数]来表示:

所以设置如下:

地址格式:用[地址参数]表示改变的页码。

数字变化:从1开始,即第一页;每增加1,即每页变化的次数;一共5条,也就是一共采集5页。

预览:采集器会根据上面的设置生成一部分URL,让你判断添加的是否正确。

然后确认

(3)【普通模式】获取内容URL

普通模式:该模式默认抓取一级地址,即从起始页的源码中获取到内容页A的链接。

下面我就通过自动获取地址链接+设置区域的方式来教大家如何获取。

查看页面源码,找到文章地址所在的区域:

设置如下:

注:更详细的分析说明请参考本手册:

操作指南> 软件操作> URL 采集规则> 获取内容URL

点击网址采集测试查看测试结果

(3)内容采集网址

经过

以标签为例说明采集

注:更详细的分析说明请参考本手册

操作指南>软件操作>内容采集规则>标签编辑

我们首先查看它的页面源码,找到我们的“title”所在的代码:

导入Excle弹出对话框~打开Excle时出错-优采云采集器帮助中心

分析表明: 开头的字符串是:

结束字符串是:

数据处理-内容替换/排除:需要替换-优采云采集器帮助中心清空

设置内容标签的原理类似,在源码中找到内容的位置

分析表明: 开头的字符串是:

结束字符串是:

数据处理-HTML标签排除:过滤不需要的A链接等。

设置另一个“源”字段

这么简单的文章采集规则就完成了。不知道网友们有没有学到。网络爬虫工具,顾名思义,适用于网页上的数据爬取。从上面的例子大家可以看出,这类软件主要是通过源码分析来分析数据的。还有一些情况这里没有列出,比如登录采集,使用代理采集等,如果你对网络爬虫工具感兴趣,可以登录采集官网@采集器 自学。 查看全部

文章网址采集器(优采云采集器V9为例,讲解一个文章采集的实例(组图))

在日常工作和学习中,一些对采集有价值的文章可以帮助我们提高信息的利用率和整合率,对于新闻、学术论文等类型的电子文章,我们可以使用网络爬虫工具执行采集,这种采集比较容易比较一些数字化的不规则数据,这里以网络爬虫工具优采云采集器V9为例,解释一个文章采集的例子供大家学习。

熟悉优采云采集器的朋友都知道,采集过程中遇到的问题可以通过官网的FAQ找回,所以这里我们就取采集以faq为例来说明网页爬虫采集的原理和过程。

在这个例子中

演示地址。

(1)创建一个新的采集规则

选择一个组,右击,选择“新建任务”,如下图:

(2)添加起始地址

假设这里我们需要采集 5页数据。

解析URL变量的规律

第一页地址:

第二页地址:

第三页地址:

由此我们可以推断出p=后面的数字是分页的意思,我们用[地址参数]来表示:

所以设置如下:

地址格式:用[地址参数]表示改变的页码。

数字变化:从1开始,即第一页;每增加1,即每页变化的次数;一共5条,也就是一共采集5页。

预览:采集器会根据上面的设置生成一部分URL,让你判断添加的是否正确。

然后确认

(3)【普通模式】获取内容URL

普通模式:该模式默认抓取一级地址,即从起始页的源码中获取到内容页A的链接。

下面我就通过自动获取地址链接+设置区域的方式来教大家如何获取。

查看页面源码,找到文章地址所在的区域:

设置如下:

注:更详细的分析说明请参考本手册:

操作指南> 软件操作> URL 采集规则> 获取内容URL

点击网址采集测试查看测试结果

(3)内容采集网址

经过

以标签为例说明采集

注:更详细的分析说明请参考本手册

操作指南>软件操作>内容采集规则>标签编辑

我们首先查看它的页面源码,找到我们的“title”所在的代码:

导入Excle弹出对话框~打开Excle时出错-优采云采集器帮助中心

分析表明: 开头的字符串是:

结束字符串是:

数据处理-内容替换/排除:需要替换-优采云采集器帮助中心清空

设置内容标签的原理类似,在源码中找到内容的位置

分析表明: 开头的字符串是:

结束字符串是:

数据处理-HTML标签排除:过滤不需要的A链接等。

设置另一个“源”字段

这么简单的文章采集规则就完成了。不知道网友们有没有学到。网络爬虫工具,顾名思义,适用于网页上的数据爬取。从上面的例子大家可以看出,这类软件主要是通过源码分析来分析数据的。还有一些情况这里没有列出,比如登录采集,使用代理采集等,如果你对网络爬虫工具感兴趣,可以登录采集官网@采集器 自学。

文章网址采集器(HTTP客户端/awaitawait//async/)

采集交流 • 优采云 发表了文章 • 0 个评论 • 166 次浏览 • 2021-12-05 19:09

HTTP 客户端是一种工具,可以向服务器发送请求,然后接收服务器的响应。下面提到的所有工具的底层都是使用一个HTTP客户端来访问你想要抓取的网站。

要求

Request 是 Javascript 生态系统中使用最广泛的 HTTP 客户端之一,但 Request 库的作者已正式声明它已被弃用。但这并不意味着它不可用,相当多的库仍在使用它,并且非常易于使用。使用 Request 发出 HTTP 请求非常简单:

const request = require('request')

request('https://www.reddit.com/r/programming.json', function ( error,

response,

body) {

console.error('error:', error)

console.log('body:', body)

})

你可以在 Github 上找到 Request 库,安装非常简单。您还可以找到弃用通知及其含义。

阿克西奥斯

Axios 是一个基于 Promise 的 HTTP 客户端,可以在浏览器和 Node.js 中运行。如果您使用 Typescript,那么 axios 将为您覆盖内置类型。通过 Axios 发起 HTTP 请求非常简单。默认情况下,它带有 Promise 支持,而不是在请求中使用回调:

const axios = require('axios')

axios

.get('https://www.reddit.com/r/programming.json')

.then((response) => {

console.log(response)

})

.catch((error) => {

console.error(error)

});

如果你喜欢 Promises API 的 async/await 语法糖,你也可以使用它,但由于顶级 await 仍处于第 3 阶段,我们不得不使用异步函数来代替:

async function getForum() {

try {

const response = await axios.get(

'https://www.reddit.com/r/programming.json'

)

console.log(response)

} catch (error) {

console.error(error)

}

}

您所要做的就是致电 getForum!可以在 Axios 库上找到。

超级代理

与 Axios 一样,Superagent 是另一个强大的 HTTP 客户端,支持 Promise 和 async/await 语法糖。它有一个类似 Axios 的相当简单的 API,但由于更多的依赖关系,Superagent 不太受欢迎。

使用 promise、async/await 或回调向 Superagent 发出 HTTP 请求如下所示:

const superagent = require("superagent")

const forumURL = "https://www.reddit.com/r/programming.json"

// callbacks

superagent

.get(forumURL)

.end((error, response) => {

console.log(response)

})

// promises

superagent

.get(forumURL)

.then((response) => {

console.log(response)

})

.catch((error) => {

console.error(error)

})

// promises with async/await

async function getForum() {

try {

const response = await superagent.get(forumURL)

console.log(response)

} catch (error) {

console.error(error)

}

}

您可以在以下位置找到 Superagent。

正则表达式:艰难的方式

在没有任何依赖的情况下,进行网络爬虫最简单的方法是在使用 HTTP 客户端查询网页时,在接收到的 HTML 字符串上使用一堆正则表达式。正则表达式不是那么灵活,许多专业人士和业余爱好者都很难写出正确的正则表达式。

试试看,假设有一个带有用户名的标签,而我们需要那个用户名,这类似于你依赖正则表达式时必须做的

const htmlString = 'Username: John Doe'

const result = htmlString.match(/(.+)/)

console.log(result[1], result[1].split(": ")[1])

// Username: John Doe, John Doe

在 Javascript 中,match() 通常返回一个数组,其中收录与正则表达式匹配的所有内容。第二个元素(在索引 1 中)将找到我们想要的标记的 textContent 或 innerHTML。但结果收录一些不必要的文本(“用户名:”),必须删除。

如您所见,对于一个非常简单的用例,有许多步骤和工作要做。这就是为什么你应该依赖 HTML 解析器的原因,我们将在后面讨论。

Cheerio:用于遍历 DOM 的核心 JQuery

Cheerio 是一个高效且可移植的库,它允许您在服务器端使用 JQuery 丰富而强大的 API。如果您之前使用过 JQuery,您就会熟悉 Cheerio。它消除了 DOM 的所有不一致和浏览器相关功能,并公开了一个有效的 API 来解析和操作 DOM。

const cheerio = require('cheerio')

const $ = cheerio.load('Hello world')

$('h2.title').text('Hello there!')

$('h2').addClass('welcome')

$.html()

// Hello there!

如您所见,Cheerio 与 JQuery 非常相似。

但是,即使它的工作方式与 Web 浏览器不同,这也意味着它不能:

因此,如果您尝试抓取的网站 或 web 应用程序严重依赖 Javascript(例如“单页应用程序”),那么 Cheerio 不是最佳选择,您可能不得不依赖其他选项稍后讨论。

为了展示 Cheerio 的强大功能,我们将尝试爬取 Reddit 中的 r/programming 论坛,并尝试获取一个帖子名称列表。

首先,通过运行以下命令安装 Cheerio 和 axios:npm installcheerio axios。

然后新建一个名为crawler.js的文件,复制粘贴以下代码:

const axios = require('axios');

const cheerio = require('cheerio');

const getPostTitles = async () => {

try {

const { data } = await axios.get(

'https://old.reddit.com/r/programming/'

);

const $ = cheerio.load(data);

const postTitles = [];

$('div > p.title > a').each((_idx, el) => {

const postTitle = $(el).text()

postTitles.push(postTitle)

});

return postTitles;

} catch (error) {

throw error;

}

};

getPostTitles()

.then((postTitles) => console.log(postTitles));

getPostTitles() 是一个异步函数,它将抓取旧的 reddit r/编程论坛。首先通过axios HTTP客户端库使用简单的HTTP GET请求获取网站的HTML,然后使用cheerio.load()函数将html数据输入到Cheerio中。

然后在浏览器的开发工具的帮助下,你可以得到一个可以定位所有列表项的选择器。如果你用过JQuery,你一定对$('div> p.title> a')非常熟悉。这将获得所有帖子,因为您只想单独获取每个帖子的标题,因此您必须遍历每个帖子。这些操作是在 each() 函数的帮助下完成的。

要从每个标题中提取文本,您必须在 Cheerio 的帮助下获取 DOM 元素(el 指的是当前元素)。然后在每个元素上调用 text() 为您提供文本。

现在,打开终端,运行node crawler.js,你会看到一个近似titles的数组,这个数组会很长。虽然这是一个非常简单的用例,但它展示了 Cheerio 提供的 API 的简单本质。

如果您的用例需要执行 Javascript 并加载外部源,那么以下选项会有所帮助。

JSDOM:节点的 DOM

JSDOM 是 Node.js 中使用的文档对象模型的纯 Javascript 实现。如前所述,DOM 对 Node 不可用,但 JSDOM 是最接近的。它或多或少地模仿了浏览器。

因为DOM是创建的,所以你可以通过编程与web应用或者你想爬取的网站进行交互,也可以模拟点击一个按钮。如果你熟悉 DOM 操作,使用 JSDOM 会非常简单。

const { JSDOM } = require('jsdom')

const { document } = new JSDOM(

'Hello world'

).window

const heading = document.querySelector('.title')

heading.textContent = 'Hello there!'

heading.classList.add('welcome')

heading.innerHTML

// Hello there!

在代码中用JSDOM创建一个DOM,然后你就可以用和浏览器DOM一样的方法和属性来操作这个DOM了。

为了演示如何使用JSDOM与网站进行交互,我们将获取Reddit r/programming论坛的第一篇帖子并对其进行投票,然后验证该帖子是否已被投票。

首先运行以下命令安装jsdom和axios: npm install jsdom axios

然后创建一个名为 crawler.js 的文件,并复制并粘贴以下代码:

const { JSDOM } = require("jsdom")

const axios = require('axios')

const upvoteFirstPost = async () => {

try {

const { data } = await axios.get("https://old.reddit.com/r/programming/");

const dom = new JSDOM(data, {

runScripts: "dangerously",

resources: "usable"

});

const { document } = dom.window;

const firstPost = document.querySelector("div > div.midcol > div.arrow");

firstPost.click();

const isUpvoted = firstPost.classList.contains("upmod");

const msg = isUpvoted

? "Post has been upvoted successfully!"

: "The post has not been upvoted!";

return msg;

} catch (error) {

throw error;

}

};

upvoteFirstPost().then(msg => console.log(msg));

upvoteFirstPost() 是一个异步函数,它将获得 r/programming 中的第一篇文章,然后对其进行投票。axios 发送 HTTP GET 请求以获取指定 URL 的 HTML。然后从之前获得的 HTML 创建一个新的 DOM。JSDOM 构造函数将 HTML 作为第一个参数,将选项作为第二个参数。添加的两个选项执行以下功能:

创建DOM后,使用相同的DOM方法获取第一篇文章文章的upvote按钮,然后点击。要验证它是否真的被点击,您可以检查 classList 中是否有名为 upmod 的类。如果它存在于 classList 中,则返回一条消息。

打开终端并运行 node crawler.js,然后您将看到一个整洁的字符串,表明该帖子是否已被点赞。虽然这个例子很简单,但你可以在这个基础上构建强大的东西,例如,一个对特定用户帖子进行投票的机器人。

如果你不喜欢缺乏表达能力的 JSDOM,并且在实践中依赖很多这样的操作,或者需要重新创建很多不同的 DOM,那么下面的将是更好的选择。

Puppeteer:无头浏览器

顾名思义,Puppeteer 允许您以编程方式操纵浏览器,就像操纵木偶一样。默认情况下,它为开发人员提供了高级 API 来控制无头版本的 Chrome。

Puppeteer 比上述工具更有用,因为它允许您像真人与浏览器交互一样抓取网络。这开辟了一些以前不可用的可能性:

它还可以在网络爬虫以外的任务中发挥重要作用,例如 UI 测试、辅助性能优化等。

通常你想截取网站的截图,也许是为了了解竞争对手的产品目录,你可以使用puppeteer来做。首先运行以下命令安装puppeteer: npm install puppeteer

这将下载 Chromium 的捆绑版本,大约 180 MB 到 300 MB,具体取决于操作系统。如果要禁用此功能。

我们尝试在 Reddit 中获取 r/programming 论坛的截图和 PDF,创建一个名为 crawler.js 的新文件,并复制并粘贴以下代码:

const puppeteer = require('puppeteer')

async function getVisual() {

try {

const URL = 'https://www.reddit.com/r/programming/'

const browser = await puppeteer.launch()

const page = await browser.newPage()

await page.goto(URL)

await page.screenshot({ path: 'screenshot.png' })

await page.pdf({ path: 'page.pdf' })

await browser.close()

} catch (error) {

console.error(error)

}

}

getVisual()

getVisual() 是一个异步函数,它将获取 URL 变量中的 url 对应的屏幕截图和 pdf。首先通过 puppeteer.launch() 创建一个浏览器实例,然后创建一个新页面。您可以将此页面视为常规浏览器中的选项卡。然后以 URL 为参数调用 page.goto() 将之前创建的页面定向到指定的 URL。最终,浏览器实例与页面一起被销毁。

操作完成并加载页面后,将分别使用 page.screenshot() 和 page.pdf() 获取屏幕截图和pdf。也可以监听javascript的load事件,进行这些操作,生产环境中强烈推荐使用。

在终端上运行 node crawler.js。几秒钟后,您会注意到已创建两个文件,名为 screenshot.jpg 和 page.pdf。

Nightmare:Puppeteer 的替代品

Nightmare 是一个类似于 Puppeteer 的高级浏览器自动化库。该库使用 Electron,但据说它的速度是其前身 PhantomJS 的两倍。

如果您在某种程度上不喜欢 Puppeteer 或对 Chromium 包的大小感到沮丧,那么 nightmare 是一个理想的选择。首先,运行以下命令安装 nightmare 库: npm install nightmare

然后,一旦下载了 nightmare,我们将使用它通过 Google 搜索引擎找到 ScrapingBee 的 网站。创建一个名为 crawler.js 的文件,然后将以下代码复制并粘贴到其中:

const Nightmare = require('nightmare')

const nightmare = Nightmare()

nightmare

.goto('https://www.google.com/')

.type("input[title='Search']", 'ScrapingBee')

.click("input[value='Google Search']")

.wait('#rso > div:nth-child(1) > div > div > div.r > a')

.evaluate(

() =>

document.querySelector(

'#rso > div:nth-child(1) > div > div > div.r > a'

).href

)

.end()

.then((link) => {

console.log('Scraping Bee Web Link': link)

})

.catch((error) => {

console.error('Search failed:', error)

})

首先创建一个 Nightmare 实例,然后通过调用 goto() 将该实例定向到 Google 搜索引擎。加载后,使用其选择器获取搜索框,然后使用搜索框的值(输入标签)将其更改为“ScrapingBee”。完成后,单击“Google 搜索”按钮提交搜索表单。然后告诉 Nightmare 等到第一个链接加载完毕。一旦完成,它将使用 DOM 方法获取收录链接的锚标记的 href 属性的值。

最后,在所有操作完成后,将链接打印到控制台。

总结 查看全部

文章网址采集器(HTTP客户端/awaitawait//async/)

HTTP 客户端是一种工具,可以向服务器发送请求,然后接收服务器的响应。下面提到的所有工具的底层都是使用一个HTTP客户端来访问你想要抓取的网站。

要求

Request 是 Javascript 生态系统中使用最广泛的 HTTP 客户端之一,但 Request 库的作者已正式声明它已被弃用。但这并不意味着它不可用,相当多的库仍在使用它,并且非常易于使用。使用 Request 发出 HTTP 请求非常简单:

const request = require('request')

request('https://www.reddit.com/r/programming.json', function ( error,

response,

body) {

console.error('error:', error)

console.log('body:', body)

})

你可以在 Github 上找到 Request 库,安装非常简单。您还可以找到弃用通知及其含义。

阿克西奥斯

Axios 是一个基于 Promise 的 HTTP 客户端,可以在浏览器和 Node.js 中运行。如果您使用 Typescript,那么 axios 将为您覆盖内置类型。通过 Axios 发起 HTTP 请求非常简单。默认情况下,它带有 Promise 支持,而不是在请求中使用回调:

const axios = require('axios')

axios

.get('https://www.reddit.com/r/programming.json')

.then((response) => {

console.log(response)

})

.catch((error) => {

console.error(error)

});

如果你喜欢 Promises API 的 async/await 语法糖,你也可以使用它,但由于顶级 await 仍处于第 3 阶段,我们不得不使用异步函数来代替:

async function getForum() {

try {

const response = await axios.get(