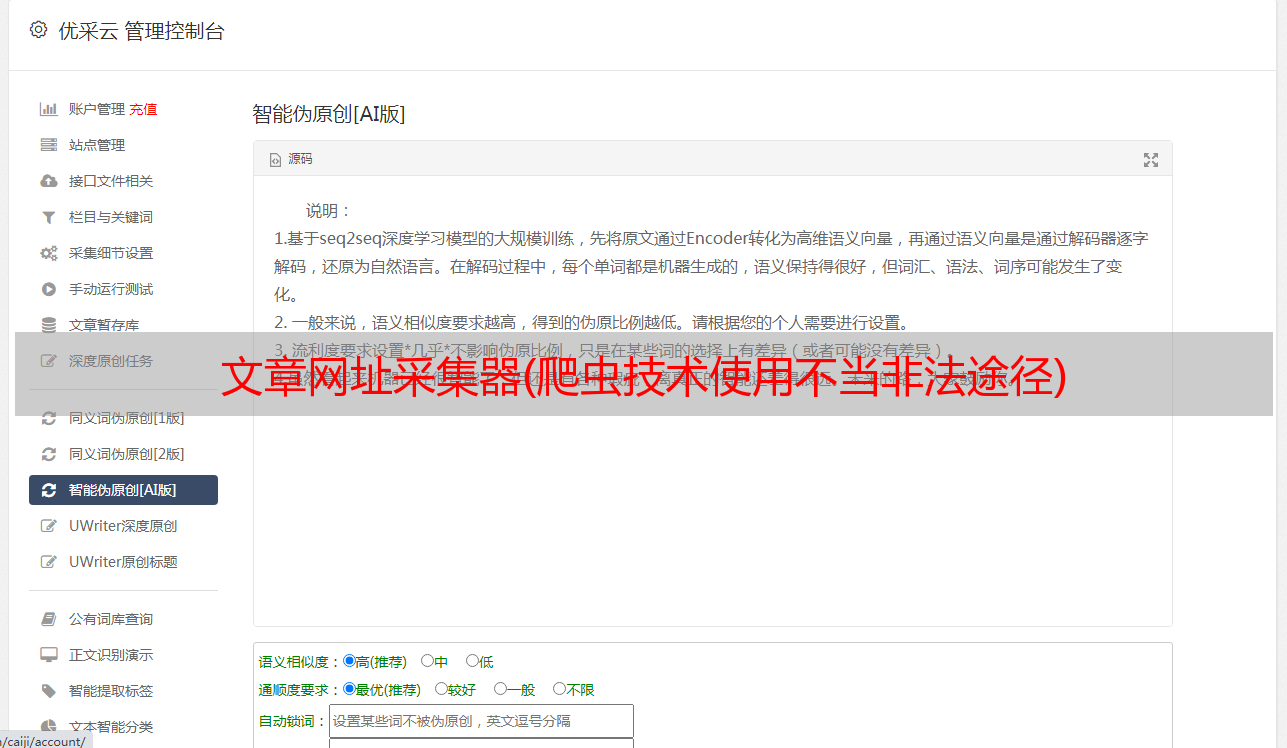

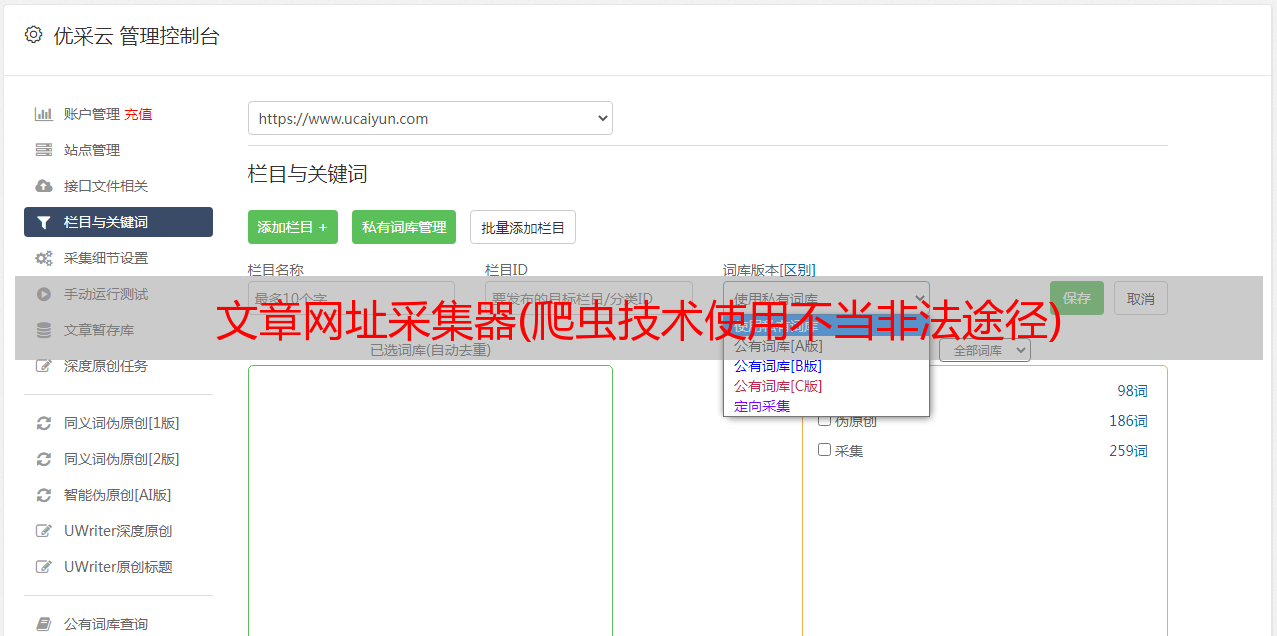

文章网址采集器(爬虫技术使用不当非法途径)

优采云 发布时间: 2021-12-05 19:08文章网址采集器(爬虫技术使用不当非法途径)

免责声明:本文仅供学习使用,禁止非法使用。爬虫技术使用不当造成的一切不良后果与我无关

需要使用的库和模块要获取的信息

网站

首先我们要确定我们想要得到什么数据

主要步骤

(一)构建请求头

headers = {

'User-Agent': '****************',#可填入自己的

}

base_url = 'http://www.aixiawx.com/27/27010/'

(二)解析URL参数的规则

刚打开小说的一章,可以看到url参数在增加,对吗?

但是一开始我观察到这里的URL有递增规律,所以没多看几眼,然后用遍历,出现了Error。

最后我测试了一下,发现有些章节不符合规律,所以不能用这个方法来遍历URL。

我能做什么?

在目录页面上有所有章节的 url 链接

可以抓取章节页面的url,形成一个列表,然后遍历列表,获取每个章节的链接

目录页面分析

从章节数来看,label是最合适的选择label,所以我们使用label来获取章节链接的top index

代码显示如下:

<p>def analysis_catalogue(catalogue_html: "目录HTML文档"):

'''

解析目录HTMl文档

获取小说章节链接

对章节链接排序

'''

html = etree.HTML(catalogue_html)

contentds = html.xpath('//dd[position()>9]/a/@href')

for contentd in contentds:

yield contentd

contentus = html.xpath('//dd[position()9]/a/@href')

for contentd in contentds:

yield contentd

contentus = html.xpath('//dd[position()