搜索引擎主题模型优化

随机冲浪模型(搜索引擎会选用种子站点作为超始站点)

网站优化 • 优采云 发表了文章 • 0 个评论 • 106 次浏览 • 2021-05-21 01:08

随机冲浪模型(搜索引擎将选择种子站点作为超级起源站点)

第一步:首先,用户将随机使用一个网页作为浏览Internet的起始网页。许多公司都在进行网站导航。

步骤2:网页与网页之间的链接称为超链接,因此在阅读网页后,用户将随机选择要浏览的页面。

第3步:然后用户沿着超链接一一点击。

每个链接的访问次数越多,它就越重要。可能的退货数量也定义为网页的权重。 PR,PR公式和公式都是基于此原理的。

PR(链接所在页面的输出越少,页面本身的权重就越高,并且外部总数越多。)

百度SEO优化

影响公关的因素

如何增加1、个链接的访问次数(概率)?例如,hao123页面不是显眼的位置。随机的机会越高,访问次数就越多。如何增加体重和出现次数,但只能有一个友情链接。从1到100随机出现的概率是1。/ 100,如果是1-5,则随机出现的概率是1/5,这是为了减少他的链接数。传递的重量越高。简而言之:将链接保留在链接较少的页面上。

2、您的链接在页面上的权重更高吗?

注意:PR与此页面上的导出链接无关。

PR如何计算?

每个网页都有初始权重。如果为1,则Internet上有数百个网页,我们会对其进行缩小。例如,如果有100个网页,则第一个网页指向第二个网页,然后第二个单一网页为2,第二个网页指向第三网页,第三个网页为3。这具有衰减值。 Google分析所有这些链接以确定PR值。当然,这是非常低的。算法。

关键词排名

外部链接的数量应按数量计算。使用Yahoo网站管理员工具进行检查。他的结果是高到低,这取决于链接了多少个首页链接及其权重。如果这些不高,我们会发现一个高度相关的外部链接肯定会超过网站个数字。

PR改进算法

1、页面的相关性越强,相关性就越高。

群组发布软件:群组发布,博客发布,此文章应该与您的主题相关。发出超过80%的群组时,要删除它并不容易。另一件事是让搜索引擎收录,如果不是收录,则它也是无效的。

2、链接所在的部分位于噪声部分。噪声部分中的链接权重非常低,并且是否有很多支持都无关紧要。

SEO优化网络提示:本文摘自[Fatty SEO]

SEO 网站优化

要重印“搜索引擎随机冲浪模型和pr公式”,请注明出处:Anzai SEO优化网络! 查看全部

随机冲浪模型(搜索引擎会选用种子站点作为超始站点)

随机冲浪模型(搜索引擎将选择种子站点作为超级起源站点)

第一步:首先,用户将随机使用一个网页作为浏览Internet的起始网页。许多公司都在进行网站导航。

步骤2:网页与网页之间的链接称为超链接,因此在阅读网页后,用户将随机选择要浏览的页面。

第3步:然后用户沿着超链接一一点击。

每个链接的访问次数越多,它就越重要。可能的退货数量也定义为网页的权重。 PR,PR公式和公式都是基于此原理的。

PR(链接所在页面的输出越少,页面本身的权重就越高,并且外部总数越多。)

百度SEO优化

影响公关的因素

如何增加1、个链接的访问次数(概率)?例如,hao123页面不是显眼的位置。随机的机会越高,访问次数就越多。如何增加体重和出现次数,但只能有一个友情链接。从1到100随机出现的概率是1。/ 100,如果是1-5,则随机出现的概率是1/5,这是为了减少他的链接数。传递的重量越高。简而言之:将链接保留在链接较少的页面上。

2、您的链接在页面上的权重更高吗?

注意:PR与此页面上的导出链接无关。

PR如何计算?

每个网页都有初始权重。如果为1,则Internet上有数百个网页,我们会对其进行缩小。例如,如果有100个网页,则第一个网页指向第二个网页,然后第二个单一网页为2,第二个网页指向第三网页,第三个网页为3。这具有衰减值。 Google分析所有这些链接以确定PR值。当然,这是非常低的。算法。

关键词排名

外部链接的数量应按数量计算。使用Yahoo网站管理员工具进行检查。他的结果是高到低,这取决于链接了多少个首页链接及其权重。如果这些不高,我们会发现一个高度相关的外部链接肯定会超过网站个数字。

PR改进算法

1、页面的相关性越强,相关性就越高。

群组发布软件:群组发布,博客发布,此文章应该与您的主题相关。发出超过80%的群组时,要删除它并不容易。另一件事是让搜索引擎收录,如果不是收录,则它也是无效的。

2、链接所在的部分位于噪声部分。噪声部分中的链接权重非常低,并且是否有很多支持都无关紧要。

SEO优化网络提示:本文摘自[Fatty SEO]

SEO 网站优化

要重印“搜索引擎随机冲浪模型和pr公式”,请注明出处:Anzai SEO优化网络!

谈搜索引擎优化的链接策略毕业论文摘要:索引擎优化基本技术

网站优化 • 优采云 发表了文章 • 0 个评论 • 99 次浏览 • 2021-05-21 01:02

谈论搜索引擎优化毕业论文的链接策略。doc谈论搜索引擎优化毕业论文的链接策略

摘要:搜索引擎优化技术是消除那些被搜索引擎识别为***的方法,并寻求基本的优化策略,例如关键字的选择和链接策略的分析。本文重点探讨搜索引擎优化技术中链接策略的研究。

关键词:搜索引擎:优化技术;链接策略

链接是网站的灵魂。用户通过超链接获得网站的丰富内容,搜索引擎蜘蛛也跟踪网站页面链接逐层进行深入跟踪,以完成网站的信息捕获。对于搜索引擎,尤其是Google,确定网站排名的关键是有多少高质量的外部链接指向该网站。这是外部链接或反向链接,也称为导入链接(入站链接或反向链接)。从网站到其他网站的派生链接以及网站内部页面之间的链接也或多或少地影响了排名。

基本的搜索引擎优化技术

细分了搜索引擎优化技术,并且需要注意很多方面。在这里,我们主要分析那些基本或关键问题。这些问题将在搜索引擎优化技术中长期占据相对重要的位置。

1、 网站关键字分析和选择

尽管网站的内容不同,但网站的目的是使目标客户更容易找到网站本身。因此,网站的重点,即关键字在网站中的作用是显而易见的。

2、 网站链接建立

因为,对于网站,两个最重要的点是内容和链接。因此,在第四章中,本文主要说明如何为网站创建链接,包括导入链接,导出链接和网站内部链接。

3、搜索引擎优化技术的完善

首先,通过研究长尾理论,使用数学模型来表达长尾理论与现实的结合。研究长尾理论经济模型的可行性,以及如何使用长尾理论改进搜索引擎优化技术。 (摘自z)链接和网站,因此搜索引擎在算法调整中仅关注高质量的外部链接,并经常惩罚类似垃圾邮件的行为,甚至在严重的情况下甚至删除网站。

因此,今天我们需要对链接的广度有一个这样的了解:即使您从劣质或不相关的站点获得了数百个链接,从具有高度相关性或互补性的高质量站点获得的链接也不值得内容。 。以下是链接质量和链接获取的分析。

1、导入链接的质量分析

以下网站中的链接都可以称为高质量导入链接。搜索引擎目录中的链接,以及指向已添加到该目录的网站的链接; 网站与网站主题相关或互补的; 网站 PR值不小于4;重要信息网站(例如搜索引擎新闻来源):网站,导出链接很少:使用关键字作为关键字,并在搜索结果的前三页中排名网站;高质量的内容网站。

2、垃圾邮件链接

与高质量链接相比,以下链接称为垃圾邮件链接,它们对网站的排名没有影响或有反作用。留言簿,评论或BBS中的大量帖子是网站的链接。以下链接通常称为垃圾邮件链接:

([3)还有两种被误认为会增加链接宽度的导入链接:

①单击付费搜索引擎广告链接,例如百度竞价排名和Google的正确关键字广告。 ②多级网络成员联盟(Affiliateprogram)链接。这些链接不会直接指向您的网站,而是指向领导者的网站以帮助他们跟踪点击次数和帐单,因此不会增加网站链接的广度。当然,如果您自己托管会员联盟,则服务器正在跟踪会员网站,并将其指向您的站点。在这种情况下,它将有助于增加链接的宽度。

([二)导出链接

导出链接是网站中与其他网站的链接。除了分析您导入的链接之外,搜索引擎机器人还将分析 查看全部

谈搜索引擎优化的链接策略毕业论文摘要:索引擎优化基本技术

谈论搜索引擎优化毕业论文的链接策略。doc谈论搜索引擎优化毕业论文的链接策略

摘要:搜索引擎优化技术是消除那些被搜索引擎识别为***的方法,并寻求基本的优化策略,例如关键字的选择和链接策略的分析。本文重点探讨搜索引擎优化技术中链接策略的研究。

关键词:搜索引擎:优化技术;链接策略

链接是网站的灵魂。用户通过超链接获得网站的丰富内容,搜索引擎蜘蛛也跟踪网站页面链接逐层进行深入跟踪,以完成网站的信息捕获。对于搜索引擎,尤其是Google,确定网站排名的关键是有多少高质量的外部链接指向该网站。这是外部链接或反向链接,也称为导入链接(入站链接或反向链接)。从网站到其他网站的派生链接以及网站内部页面之间的链接也或多或少地影响了排名。

基本的搜索引擎优化技术

细分了搜索引擎优化技术,并且需要注意很多方面。在这里,我们主要分析那些基本或关键问题。这些问题将在搜索引擎优化技术中长期占据相对重要的位置。

1、 网站关键字分析和选择

尽管网站的内容不同,但网站的目的是使目标客户更容易找到网站本身。因此,网站的重点,即关键字在网站中的作用是显而易见的。

2、 网站链接建立

因为,对于网站,两个最重要的点是内容和链接。因此,在第四章中,本文主要说明如何为网站创建链接,包括导入链接,导出链接和网站内部链接。

3、搜索引擎优化技术的完善

首先,通过研究长尾理论,使用数学模型来表达长尾理论与现实的结合。研究长尾理论经济模型的可行性,以及如何使用长尾理论改进搜索引擎优化技术。 (摘自z)链接和网站,因此搜索引擎在算法调整中仅关注高质量的外部链接,并经常惩罚类似垃圾邮件的行为,甚至在严重的情况下甚至删除网站。

因此,今天我们需要对链接的广度有一个这样的了解:即使您从劣质或不相关的站点获得了数百个链接,从具有高度相关性或互补性的高质量站点获得的链接也不值得内容。 。以下是链接质量和链接获取的分析。

1、导入链接的质量分析

以下网站中的链接都可以称为高质量导入链接。搜索引擎目录中的链接,以及指向已添加到该目录的网站的链接; 网站与网站主题相关或互补的; 网站 PR值不小于4;重要信息网站(例如搜索引擎新闻来源):网站,导出链接很少:使用关键字作为关键字,并在搜索结果的前三页中排名网站;高质量的内容网站。

2、垃圾邮件链接

与高质量链接相比,以下链接称为垃圾邮件链接,它们对网站的排名没有影响或有反作用。留言簿,评论或BBS中的大量帖子是网站的链接。以下链接通常称为垃圾邮件链接:

([3)还有两种被误认为会增加链接宽度的导入链接:

①单击付费搜索引擎广告链接,例如百度竞价排名和Google的正确关键字广告。 ②多级网络成员联盟(Affiliateprogram)链接。这些链接不会直接指向您的网站,而是指向领导者的网站以帮助他们跟踪点击次数和帐单,因此不会增加网站链接的广度。当然,如果您自己托管会员联盟,则服务器正在跟踪会员网站,并将其指向您的站点。在这种情况下,它将有助于增加链接的宽度。

([二)导出链接

导出链接是网站中与其他网站的链接。除了分析您导入的链接之外,搜索引擎机器人还将分析

这就是搜索引擎:核心技术详解(一书)

网站优化 • 优采云 发表了文章 • 0 个评论 • 125 次浏览 • 2021-05-21 01:01

摘要:我最近阅读了《这是搜索引擎:核心技术的详细说明》这本书,并做了简短记录。

__________________________________________________

内容

【1】搜索引擎概述

[2]搜索引擎的基本技术

[3]搜索引擎的平台基础

[4]搜索结果的改进和优化

__________________________________________________

【1】搜索引擎概述

在过去的15年中,Internet信息迅速发展,不再可能通过手工方法筛选和获取有用的信息。因此,出现了搜索引擎。根据其发展,它可以分为四个时代。

谈到发展,我不得不提到搜索引擎的三个主要目标。无论在哪里发展,以下三个目标始终是一个很好的评估标准:

[2]搜索引擎的基本技术

这部分主要从以下四个部分描述搜索引擎的基本技术,这也是搜索引擎的重要链接。

2. 1个Web爬网程序

网络采集器是搜索引擎的下载系统。它的功能是获取内容。该方法是通过万维网中的链接连续地爬网和采集各种网页。但是,Internet上有很多页面,并且每天都在不断产生新的内容。根据搜寻目标和范围,采集器可以简单地分为以下几类:

搜寻网页时,采集器应如何确定其下一个目标?主要策略如下:

接下来,简要介绍一下搜索引擎中的一个重要问题:暗网爬网。所谓的暗网是指难以通过常规方法进行爬网的网页,并且互联网上存在大量这样的网。某些网页没有外部链接,一些主要内容存储在数据库(例如Ctrip)中,并且没有指向这些记录的链接。暗网挖掘是商业搜索引擎的主要研究重点,谷歌就是这样,百度的“阿拉丁”计划也在这里。

2. 2创建索引

对于搜索引擎而言,搜索是最重要的核心技术之一。面对大量的网络内容,如何快速查找收录用户查询的所有网页?倒排索引在其中起着关键作用。

对于网页,我们将其视为文档,其内容由文字组成。为了快速提供用户搜索词的文档结果,我们必须建立单词文档存储结构。倒排索引是一种实现词文档矩阵的特定存储形式。通过倒排索引,您可以根据单词快速获取收录该单词的文档列表。倒排索引主要由两部分组成:单词字典和倒排文件。

单词字典主要以两种方式存储:散列加链接和树形结构。

如何创建索引:

([1)两次文档遍历

在扫描文档集合的第一阶段中,此方法不会立即开始建立索引,而是会采集一些全局统计信息。例如,文档集合中收录的文档数量为N,文档集合中收录的不同单词的数量M,以及每个单词出现在多少文档中的信息DF。获得上述三种类型的信息后,您可以知道最终索引的大小,然后在内存中分配足够的空间来存储反向索引的内容。在第二次扫描中,实际上建立了每个单词的倒排列表信息,即对于一个单词,收录该单词的每个文档的文档ID和文档TF中该单词出现的次数

([2)排序方法

排序方法对此进行了改进。在索引过程中,此方法始终在内存中分配固定大小的空间,以存储字典信息和索引的中间结果。当分配的空间用完时,此时,中间结果将写入磁盘,并且中间结果在内存中占据的空间将被清除,以用作下一个存储索引中间结果的存储区圆形的。此方法仅需要固定大小的内存,因此它可以索引任何大小的文档集合。

([3)合并方法

当分配的内存配额用完时,排序方法仅将中间结果写入磁盘,并且字典信息已保留在内存中。随着越来越多的文档被处理,词典中包括了更多的词典项目。越来越多,因此占用了越来越多的内存,导致后期阶段中间结果的可用内存越来越少。合并方法已对此进行了改进,也就是说,每次将内存中的数据写入磁盘时,都会将包括字典在内的所有中间结果信息写入磁盘,以便可以清空内存中的所有内容,并且随后的索引可以用于所有配额内存。

索引更新策略:

2. 3内容检索

内容检索模型是搜索引擎排名的理论基础,用于计算网页和查询的相关性。

常用的检索模型

检索系统评估指标

与查询相关

查询无关

在搜索结果中

A

B

不在搜索结果中

C

D

2. 4链接分析

搜索引擎找到可以满足用户请求的网页时,主要考虑两个因素:一是用户发送的查询与网页内容之间的内容相似性得分,即网页的相关性和查询;另一个是通过链接分析方法获得的分数是网页的重要性。链接分析是通过网络的链接结构获得网页重要性的一种方法。

有许多链接分析算法。从模型的角度来看,它们主要分为两类:

常用算法:

[3]搜索引擎的平台基础

这部分主要讨论搜索引擎的平台支持,主要是云存储和云计算模型。

对于商业搜索引擎,需要保存大量数据,并且需要处理这些大规模海量数据。云存储和云计算是解决此问题的方法。

服务器上不能存在大量数据,它必须是分布式存储。更新数据时,这将导致多台服务器上的数据不一致,以及如何选择服务器的问题。

首先让我们介绍一些基本原则:

([1) CAP原则

CAP是一致性,可用性,分区容忍度的缩写,即一致性,可用性和分区容忍度。

对于数据系统,这三个原则不能兼得。云存储通常专注于CA,这会牺牲一些一致性。

([2) ACID原则

这是关系数据库采用的原理。它是原子性,一致性,隔离性,耐久性的缩写,即原子性,一致性,事务独立性和持久性。

([3) BASE原理

所采用的大型多云存储系统与ACID不同,它牺牲了强大的数据一致性以换取高可用性。因为用户可能对数据更改敏感,因此无法提供服务。

它的三个方面是:

Google的云存储和云计算架构

云存储:

云计算

其他云存储系统

[4]搜索结果的改进和优化

如前所述,搜索引擎追求的三个目标是更快,更全面和更准确。但是要实现这些目标并不是一件容易的事,并且需要处理许多链接。本部分主要从以下几个方面进行论述,如何改善搜索引擎的搜索结果,提高搜索质量,以及提高搜索性能。

4. 1作弊分析

作弊方法

反作弊的整体思想

(1)所谓的信任传播模型,其基本思想如下:在海量Web数据中,通过某些技术手段或手动和半手动手段,筛选出一些完全值得信赖的页面,这意味着页面(可以理解为白名单),该算法将白名单中的这些页面用作起点,并为白名单中的页面节点分配较高的信任度。白名单中的节点和白名单中的节点,由链接关系决定,白名单中的节点通过该链接关系向外扩展信任度,如果节点获得的信任度高于某个阈值,则认为没问题,并且低于此阈值的网页将被视为欺诈网页。

(2)在框架方面,不信任分发模型与信任分发模型类似。最大的不同是页面的初始子集不是可信任的页面节点,而是确认作弊采集存在的页面,即是不信任页面的集合(可以理解为黑名单),为该黑名单中的页面节点分配不信任分数,并通过链接关系传播该不信任关系;如果最后一个页面节点的不信任分数大于设置的阈值将被视为作弊网页。

(3)异常发现模型也是一个高度抽象的算法框架模型。其基本假设是:作弊网页必须具有与普通网页不同的功能。该功能可能是内容,也可能是链接制定特定算法的过程通常是查找作弊网页的集合,分析其异常特征,然后使用这些异常特征来识别作弊网页。

只要操纵搜索引擎搜索结果可以带来好处,那么作弊的动机就永远存在,尤其是在网络营销在宣传中扮演越来越重要的时代。作弊和反作弊是相互作用的过程,相互抑制,互相促进。 “一只脚高,一只脚高”的故事不断重复。前述内容主要基于进行反作弊的技术手段。实际上,仅凭技术手段不能完全解决作弊问题。有必要将人工和技术手段结合起来以获得更好的防作弊效果。技术方法可以分为相对通用的方法和相对特殊的方法。相对通用的方法对可能出现的新作弊方法具有一定的预防能力,但是由于其通用性,它们的针对性不强,并且对特殊的作弊方法有影响。不一定好。专用的防作弊方法通常是在只有当作弊发生并且很严重时才可以总结作弊的特征并在事后采用过滤方法。人工手段和技术手段是高度互补的。一旦出现新的作弊方法,就可以发现它们,并且可以将其视为进行作弊时的预防措施。因此,考虑到从时间维度上抑制作弊方法,一般的反作弊方法侧重于预防,人工方法侧重于检测,专用的反作弊方法侧重于后处理,它们具有内在的联系和互补关系。

4. 2分析用户意图

准确分析用户的搜索意图是搜索引擎研究的当前重点。

用户意图可以大致分为

搜索日志是挖掘用户意图的重要数据源

用户在搜索时可能不会想到合适的搜索词,或者在关键词中输入错误。目前,他们需要帮助用户弄清他们的搜索意图。

常用方法是:

4. 3网页重复数据删除

根据统计,互联网上相当大比例的网页大致相同或相同,高达29%。如果搜索返回大量相似的页面,显然会降低搜索结果的质量。针对这种现象,非常有必要删除重复的网页。

网页的重复数据删除通常在采集器对网页进行爬网之后以及对其编制索引之前执行。重复数据删除算法应同时考虑准确性和操作效率。

典型的网页重复数据删除算法:

几种典型的重复数据删除算法:

4. 4缓存机制

缓存机制可以加快用户响应速度并节省计算资源

缓存系统的目标是最大化缓存命中率,并保持缓存和索引的一致性

缓存的对象主要是网页搜索结果和与查询词相对应的倒排列表

缓存消除策略主要包括动态策略和混合策略 查看全部

这就是搜索引擎:核心技术详解(一书)

摘要:我最近阅读了《这是搜索引擎:核心技术的详细说明》这本书,并做了简短记录。

__________________________________________________

内容

【1】搜索引擎概述

[2]搜索引擎的基本技术

[3]搜索引擎的平台基础

[4]搜索结果的改进和优化

__________________________________________________

【1】搜索引擎概述

在过去的15年中,Internet信息迅速发展,不再可能通过手工方法筛选和获取有用的信息。因此,出现了搜索引擎。根据其发展,它可以分为四个时代。

谈到发展,我不得不提到搜索引擎的三个主要目标。无论在哪里发展,以下三个目标始终是一个很好的评估标准:

[2]搜索引擎的基本技术

这部分主要从以下四个部分描述搜索引擎的基本技术,这也是搜索引擎的重要链接。

2. 1个Web爬网程序

网络采集器是搜索引擎的下载系统。它的功能是获取内容。该方法是通过万维网中的链接连续地爬网和采集各种网页。但是,Internet上有很多页面,并且每天都在不断产生新的内容。根据搜寻目标和范围,采集器可以简单地分为以下几类:

搜寻网页时,采集器应如何确定其下一个目标?主要策略如下:

接下来,简要介绍一下搜索引擎中的一个重要问题:暗网爬网。所谓的暗网是指难以通过常规方法进行爬网的网页,并且互联网上存在大量这样的网。某些网页没有外部链接,一些主要内容存储在数据库(例如Ctrip)中,并且没有指向这些记录的链接。暗网挖掘是商业搜索引擎的主要研究重点,谷歌就是这样,百度的“阿拉丁”计划也在这里。

2. 2创建索引

对于搜索引擎而言,搜索是最重要的核心技术之一。面对大量的网络内容,如何快速查找收录用户查询的所有网页?倒排索引在其中起着关键作用。

对于网页,我们将其视为文档,其内容由文字组成。为了快速提供用户搜索词的文档结果,我们必须建立单词文档存储结构。倒排索引是一种实现词文档矩阵的特定存储形式。通过倒排索引,您可以根据单词快速获取收录该单词的文档列表。倒排索引主要由两部分组成:单词字典和倒排文件。

单词字典主要以两种方式存储:散列加链接和树形结构。

如何创建索引:

([1)两次文档遍历

在扫描文档集合的第一阶段中,此方法不会立即开始建立索引,而是会采集一些全局统计信息。例如,文档集合中收录的文档数量为N,文档集合中收录的不同单词的数量M,以及每个单词出现在多少文档中的信息DF。获得上述三种类型的信息后,您可以知道最终索引的大小,然后在内存中分配足够的空间来存储反向索引的内容。在第二次扫描中,实际上建立了每个单词的倒排列表信息,即对于一个单词,收录该单词的每个文档的文档ID和文档TF中该单词出现的次数

([2)排序方法

排序方法对此进行了改进。在索引过程中,此方法始终在内存中分配固定大小的空间,以存储字典信息和索引的中间结果。当分配的空间用完时,此时,中间结果将写入磁盘,并且中间结果在内存中占据的空间将被清除,以用作下一个存储索引中间结果的存储区圆形的。此方法仅需要固定大小的内存,因此它可以索引任何大小的文档集合。

([3)合并方法

当分配的内存配额用完时,排序方法仅将中间结果写入磁盘,并且字典信息已保留在内存中。随着越来越多的文档被处理,词典中包括了更多的词典项目。越来越多,因此占用了越来越多的内存,导致后期阶段中间结果的可用内存越来越少。合并方法已对此进行了改进,也就是说,每次将内存中的数据写入磁盘时,都会将包括字典在内的所有中间结果信息写入磁盘,以便可以清空内存中的所有内容,并且随后的索引可以用于所有配额内存。

索引更新策略:

2. 3内容检索

内容检索模型是搜索引擎排名的理论基础,用于计算网页和查询的相关性。

常用的检索模型

检索系统评估指标

与查询相关

查询无关

在搜索结果中

A

B

不在搜索结果中

C

D

2. 4链接分析

搜索引擎找到可以满足用户请求的网页时,主要考虑两个因素:一是用户发送的查询与网页内容之间的内容相似性得分,即网页的相关性和查询;另一个是通过链接分析方法获得的分数是网页的重要性。链接分析是通过网络的链接结构获得网页重要性的一种方法。

有许多链接分析算法。从模型的角度来看,它们主要分为两类:

常用算法:

[3]搜索引擎的平台基础

这部分主要讨论搜索引擎的平台支持,主要是云存储和云计算模型。

对于商业搜索引擎,需要保存大量数据,并且需要处理这些大规模海量数据。云存储和云计算是解决此问题的方法。

服务器上不能存在大量数据,它必须是分布式存储。更新数据时,这将导致多台服务器上的数据不一致,以及如何选择服务器的问题。

首先让我们介绍一些基本原则:

([1) CAP原则

CAP是一致性,可用性,分区容忍度的缩写,即一致性,可用性和分区容忍度。

对于数据系统,这三个原则不能兼得。云存储通常专注于CA,这会牺牲一些一致性。

([2) ACID原则

这是关系数据库采用的原理。它是原子性,一致性,隔离性,耐久性的缩写,即原子性,一致性,事务独立性和持久性。

([3) BASE原理

所采用的大型多云存储系统与ACID不同,它牺牲了强大的数据一致性以换取高可用性。因为用户可能对数据更改敏感,因此无法提供服务。

它的三个方面是:

Google的云存储和云计算架构

云存储:

云计算

其他云存储系统

[4]搜索结果的改进和优化

如前所述,搜索引擎追求的三个目标是更快,更全面和更准确。但是要实现这些目标并不是一件容易的事,并且需要处理许多链接。本部分主要从以下几个方面进行论述,如何改善搜索引擎的搜索结果,提高搜索质量,以及提高搜索性能。

4. 1作弊分析

作弊方法

反作弊的整体思想

(1)所谓的信任传播模型,其基本思想如下:在海量Web数据中,通过某些技术手段或手动和半手动手段,筛选出一些完全值得信赖的页面,这意味着页面(可以理解为白名单),该算法将白名单中的这些页面用作起点,并为白名单中的页面节点分配较高的信任度。白名单中的节点和白名单中的节点,由链接关系决定,白名单中的节点通过该链接关系向外扩展信任度,如果节点获得的信任度高于某个阈值,则认为没问题,并且低于此阈值的网页将被视为欺诈网页。

(2)在框架方面,不信任分发模型与信任分发模型类似。最大的不同是页面的初始子集不是可信任的页面节点,而是确认作弊采集存在的页面,即是不信任页面的集合(可以理解为黑名单),为该黑名单中的页面节点分配不信任分数,并通过链接关系传播该不信任关系;如果最后一个页面节点的不信任分数大于设置的阈值将被视为作弊网页。

(3)异常发现模型也是一个高度抽象的算法框架模型。其基本假设是:作弊网页必须具有与普通网页不同的功能。该功能可能是内容,也可能是链接制定特定算法的过程通常是查找作弊网页的集合,分析其异常特征,然后使用这些异常特征来识别作弊网页。

只要操纵搜索引擎搜索结果可以带来好处,那么作弊的动机就永远存在,尤其是在网络营销在宣传中扮演越来越重要的时代。作弊和反作弊是相互作用的过程,相互抑制,互相促进。 “一只脚高,一只脚高”的故事不断重复。前述内容主要基于进行反作弊的技术手段。实际上,仅凭技术手段不能完全解决作弊问题。有必要将人工和技术手段结合起来以获得更好的防作弊效果。技术方法可以分为相对通用的方法和相对特殊的方法。相对通用的方法对可能出现的新作弊方法具有一定的预防能力,但是由于其通用性,它们的针对性不强,并且对特殊的作弊方法有影响。不一定好。专用的防作弊方法通常是在只有当作弊发生并且很严重时才可以总结作弊的特征并在事后采用过滤方法。人工手段和技术手段是高度互补的。一旦出现新的作弊方法,就可以发现它们,并且可以将其视为进行作弊时的预防措施。因此,考虑到从时间维度上抑制作弊方法,一般的反作弊方法侧重于预防,人工方法侧重于检测,专用的反作弊方法侧重于后处理,它们具有内在的联系和互补关系。

4. 2分析用户意图

准确分析用户的搜索意图是搜索引擎研究的当前重点。

用户意图可以大致分为

搜索日志是挖掘用户意图的重要数据源

用户在搜索时可能不会想到合适的搜索词,或者在关键词中输入错误。目前,他们需要帮助用户弄清他们的搜索意图。

常用方法是:

4. 3网页重复数据删除

根据统计,互联网上相当大比例的网页大致相同或相同,高达29%。如果搜索返回大量相似的页面,显然会降低搜索结果的质量。针对这种现象,非常有必要删除重复的网页。

网页的重复数据删除通常在采集器对网页进行爬网之后以及对其编制索引之前执行。重复数据删除算法应同时考虑准确性和操作效率。

典型的网页重复数据删除算法:

几种典型的重复数据删除算法:

4. 4缓存机制

缓存机制可以加快用户响应速度并节省计算资源

缓存系统的目标是最大化缓存命中率,并保持缓存和索引的一致性

缓存的对象主要是网页搜索结果和与查询词相对应的倒排列表

缓存消除策略主要包括动态策略和混合策略

搜索广告是搜索中商(qian)化的一环

网站优化 • 优采云 发表了文章 • 0 个评论 • 124 次浏览 • 2021-05-17 01:42

搜索广告是搜索中商(qian)化的一环

本文介绍了ACL 2020论文“学习用于电子商务产品搜索的鲁棒模型”。该论文的作者来自爱荷华州立大学和亚马逊。

作者|机智的萧萧

编辑|丛结束

论文地址:

1

经常将背景搜索和推荐进行比较。最突出的区别是搜索中有一个查询。有必要充分考虑召回内容和查询之间的相关性。如果内容是搜索广告,则内容要求更高,而相关性较低的内容将使用户体验较差。在一定程度上,相关性可以抽象为doc和查询之间的语义相似性。实际上,当前的语义相似性研究已经非常成熟。在sigir2018中,一些人对搜索和推荐中的深度学习匹配做了非常全面的研究。评论:用于搜索和推荐匹配的深度学习[1]。在语义匹配方面,每个人的重点通常是如何定义“匹配”,尤其是对如何更好地匹配两者的编码内容的分析。

实际上有两个共同的想法:尽管语义相似性问题有很多解决方案,但实际上,在应用过程中,由于搜索内容的细微变化,相关性和相似性之间仍然存在很大的差距。关于语义意图的巨大变化。例如,用户想要购买“手机充电器”,但是结果是“手机外壳”。尽管两者具有一定程度的相似性,但是它们显然不相关。回顾搜索广告,搜索广告是搜索行业的一部分。希望是给用户尽可能多的联系。最初,刊登广告的人数减少了。没关系,它甚至更酷。

别着急,我今天将介绍一种新方法,来自Amazon ACL20的“学习电子商务产品搜索的稳健模型” [3],文章主要用于产品搜索场景,目的是确定查询和项目/ doc之间的相关性。在本文中,提出了一种结构与“拮抗生成网络”相似的模型[4],其中鉴别器可以测量查询和doc之间的相关性,并确定两者是否相关,并且生成器可以生成类似的模型。但与查询无关。doc在类似于对抗生成网络模式的训练下,仍可以在噪声较大的数据下尽可能确保模型的鲁棒性。

2

模型1、问题定义

为了更好地描述模型和定义问题,使用了一对匹配对,其中文档的内容和相应的查询指出了两者之间的匹配,指出了两者不匹配,并指出了两次比赛。在建模过程中,将生成一个,那时将存在一个。 2、模型体系结构如果您想学习一些东西,在阅读本文时一定不要错过模型部分。

该模型主要分为3部分:3、分类器

如上所述,分类器是LSTM注意模式的模型。其模型基于(Rocktaschel et al。,201 5) [5]。作者认为,搜索场景的句子格式将不同于常规自然语言。首先,查询和相应的项目标题将具有一个语法结构,但有所不同,查询通常较短,标题的描述更多关键词,广告场景中的查询和标题更可能是多对一的情况,例如“红色跑步鞋Nike”和“红色”“ Nike运动鞋”都对应于同一产品;此外,查询中的属性描述(例如品牌颜色(电子商务场景))将以长句显示,因此总之,作者对项目的查询和标题进行了不同的词向量训练,最后进行合并和计算。

底部有两个输入,一个是titi,另一个是查询。两者由自己训练的word2vector编码,然后输入各自的LSTM,如图所示。可以看到的是,查询LSTM实际上使用标题LSTM的终端信息,然后输入加法注意,这实际上是一种更常规的注意方法(Bahdanau等,201 4) [6],之后,进入第三层层完全连通,匹配度计算最终完成,值得注意的是使用了内部注意,虽然笔者使用了附加注意,但也提出了改进,这种改进提升了注意方式。不收录要考虑的上下文信息基于上一期的信息模型,让我们看一下他是如何做到的:设置LSTM的输出维度,以及标题和通过相应LSTM进行查询的输出矩阵。

要了解注意力,首先要了解的是注意力的对象和基础。显然,在构造时,我们正在为查询中的LSTM输出之后的每个节点进行计算,因此该公式意味着对于查询中的每个单词,请注意标题的表示形式并获得分数。另外,它是在计算中引入的,目的是在步骤t-1之前添加模型的主要焦点信息。当然,注意力只是信息的调整。最后,必须考虑并汇总原创信息,因此有:

其中是LSTM之后查询的最终输出。您得到的是这次将查询发送到完全连接的层之前的表单。

请注意,我们发现除了计算得出的总和之外,我们还考虑了更多问题。作者给出的解释是为了提高分类的效果。具体的表现形式在于上述查询和项目之间的“多重”。在考虑查询中的每个位置与注意中的整体标题之间的关系之后,计算“一对一”的关系。通过参数训练,它实际上可以表示具有统一表达能力的整批与标题相关的查询。时间可以反映出这种所谓的“统一表达”与特定查询之间的差距。最后,当然是损失函数:

其中一个是可调整阳性样品重量的超参数。在本文中,我们将更加关注正样本(无与伦比),因此。 4、文本生成器搜索引擎下的正样本(不匹配)非常简单,但是要找到与相应标题不匹配但与对应查询相似的文本,这就是我们所说的“对抗样本”,确实不容易,我们希望找到对抗性实例来协助训练,从而提高模型的鲁棒性。在文章中,作者使用VED-变体编解码器。我们希望输入可以产生一个。这不匹配,但是非常接近(实际上,在某种程度上可以理解,我们将挖掘相似性分类的“决策边界”)。作者本人并未对VED进行很多改进,而是直接遵循了(Bahuleyan等,201 7) [7]的操作,其特定格式变得非常简单:

5、生成器和查询之间的链接

由于内部实际上涉及两个任务:分类和生成,为了使这两个端到端整体成立,有必要涉及一个统一的损失函数,权衡这两个函数,以便使两个函数都能达到最佳状态尽可能同时。返回并查看整个模型架构,尤其是橙色部分:

在这里,总和是分别通过查询LSTM的查询结果和生成的查询的结果,这是满足概率的伯努利分布。展开以查看此公式的原理。首先,如果查询本身与标题不相似,即在整个公式中仅使用原创查询。相反,如果查询被完全使用,则使用生成的查询。为了产生一定量的噪声,引入了随机数。 6、损失函数设计,训练分类和生成的双重任务,然后应仔细考虑两者的联合学习。因此,作者设计了这样一个公式:

请仔细查看此公式是否类似于上面的公式(3)?简单地说,只有当查询和标题非常相似时(负示例),才会考虑生成器生成的查询和标题。但是,实际上,我们可以发现上述损失函数,无论是查看查询还是生成的查询,都只是在分析它们与文档之间的差异,换句话说,考虑了“正样本”,但是存在没有否定样本,他们实际上是怎么做的?让我们看一下他们的训练过程。

在训练过程中,首先要做的是训练第一轮分类器,然后使用分类器对相似和不相似的查询进行划分,然后使用此数据来训练VED的第一个版本。在此基础上,使用公式(4)作为损失进行调整,最后得到所需的模型,尤其是该分类模型。

3

实验和结果具有基本模型和一定的理论基础,当然,我们必须开始实践这一内容。作者正在设计用于电子商务搜索。当然,有必要使用电子商务数据进行实验。实验数据量将达到320万对,其中只有少量是不匹配的。这里的“匹配”是指查询查询以后经常购买的那些产品的标题。 1、模型效果

以gbdt作为基准(老实说,我不太同意使用gbdt作为基准。从我的角度来看,语义相似性不是主流,而dssm是更著名的基准)。可以看出,从这个角度来看,即使只有分类器,作者的模型效果甚至比著名的bert还要高。得到了进一步的改善。离线评估的效果令人欣喜,QUARTS在网上也取得了不错的表现。经过两个国家的A / B测试,与当前基准相比,它分别增加了1 2. 2%和5. 75%。 2、生成器的效果,根据作者的分析,实际准确率可以达到82%,这是一个不错的水平,让我们来看一些情况:

可以看出,正如作者所期望的,该查询与所生成的查询具有高度的相似性,同时可以满足与相应标题的关系。

4

结论和展望阅读文章之后,我们要做的当然是吸收在文章中提到和提出的一些建模技巧:让我感到更加惊讶的是,我坐下了,bert。并且损失了很多,但这主要是因为BERT是基于DSSM的改进。实际上,您可以尝试用bert替换在此模型下经过训练的标题嵌入和查询嵌入。估计会有新的改进(但是模型估计更大)。因此,让我为您提供一些可以尽可能改进的想法(请记住,下一个最高职位将是您的)。此外,我也想提到一点,就是在bert操蛋的时候,这个模型是除了LSTM之外,它本身没有复杂的操作,并且估计耗时约为10毫秒。参考文献:

[1] SIGIR2018的报告谈到了该领域的语义匹配模型:〜hexn / papers / sigir18-tutorial-deep-matching.pdf

[2]使用点击数据学习用于网络搜索的深度结构化语义模型:

[3]学习用于电子商务产品搜索的可靠模型:

[4]冒险:针对文本蕴涵性的对抗训练,并附有知识指导的示例:

[5]与神经注意有关的必然性:

[6]通过共同学习对齐和翻译来进行神经机器翻译。

[7]序列间模型的差异关注:〜ppoupart / publications / conversational-agents / variational-attention-sequence.pdf

招聘

AI Technology Review希望招聘一名技术编辑/记者

办公地点:北京/深圳

职位:主要参加学术会议报告和个人访谈

工作内容:

1、参加各种人工智能学术会议并报告会议内容;

2、对人工智能领域的学者或研发人员的采访;

3、关注学术领域的热点事件,并及时跟进和汇报。

要求:

1、喜欢人工智能的学术研究内容,并且善于与学者或公司工程师打交道;

2、具有一定的科学和工程背景,并且对人工智能技术有一定了解的人会更好;

3、较强的英语水平(工作涉及很多英语材料);

4、较强的学习能力,对尖端的人工智能技术有一定的了解,并可以逐步形成自己的见解。

如果您有兴趣,可以将简历发送到邮箱:

查看全部

搜索广告是搜索中商(qian)化的一环

本文介绍了ACL 2020论文“学习用于电子商务产品搜索的鲁棒模型”。该论文的作者来自爱荷华州立大学和亚马逊。

作者|机智的萧萧

编辑|丛结束

论文地址:

1

经常将背景搜索和推荐进行比较。最突出的区别是搜索中有一个查询。有必要充分考虑召回内容和查询之间的相关性。如果内容是搜索广告,则内容要求更高,而相关性较低的内容将使用户体验较差。在一定程度上,相关性可以抽象为doc和查询之间的语义相似性。实际上,当前的语义相似性研究已经非常成熟。在sigir2018中,一些人对搜索和推荐中的深度学习匹配做了非常全面的研究。评论:用于搜索和推荐匹配的深度学习[1]。在语义匹配方面,每个人的重点通常是如何定义“匹配”,尤其是对如何更好地匹配两者的编码内容的分析。

实际上有两个共同的想法:尽管语义相似性问题有很多解决方案,但实际上,在应用过程中,由于搜索内容的细微变化,相关性和相似性之间仍然存在很大的差距。关于语义意图的巨大变化。例如,用户想要购买“手机充电器”,但是结果是“手机外壳”。尽管两者具有一定程度的相似性,但是它们显然不相关。回顾搜索广告,搜索广告是搜索行业的一部分。希望是给用户尽可能多的联系。最初,刊登广告的人数减少了。没关系,它甚至更酷。

别着急,我今天将介绍一种新方法,来自Amazon ACL20的“学习电子商务产品搜索的稳健模型” [3],文章主要用于产品搜索场景,目的是确定查询和项目/ doc之间的相关性。在本文中,提出了一种结构与“拮抗生成网络”相似的模型[4],其中鉴别器可以测量查询和doc之间的相关性,并确定两者是否相关,并且生成器可以生成类似的模型。但与查询无关。doc在类似于对抗生成网络模式的训练下,仍可以在噪声较大的数据下尽可能确保模型的鲁棒性。

2

模型1、问题定义

为了更好地描述模型和定义问题,使用了一对匹配对,其中文档的内容和相应的查询指出了两者之间的匹配,指出了两者不匹配,并指出了两次比赛。在建模过程中,将生成一个,那时将存在一个。 2、模型体系结构如果您想学习一些东西,在阅读本文时一定不要错过模型部分。

该模型主要分为3部分:3、分类器

如上所述,分类器是LSTM注意模式的模型。其模型基于(Rocktaschel et al。,201 5) [5]。作者认为,搜索场景的句子格式将不同于常规自然语言。首先,查询和相应的项目标题将具有一个语法结构,但有所不同,查询通常较短,标题的描述更多关键词,广告场景中的查询和标题更可能是多对一的情况,例如“红色跑步鞋Nike”和“红色”“ Nike运动鞋”都对应于同一产品;此外,查询中的属性描述(例如品牌颜色(电子商务场景))将以长句显示,因此总之,作者对项目的查询和标题进行了不同的词向量训练,最后进行合并和计算。

底部有两个输入,一个是titi,另一个是查询。两者由自己训练的word2vector编码,然后输入各自的LSTM,如图所示。可以看到的是,查询LSTM实际上使用标题LSTM的终端信息,然后输入加法注意,这实际上是一种更常规的注意方法(Bahdanau等,201 4) [6],之后,进入第三层层完全连通,匹配度计算最终完成,值得注意的是使用了内部注意,虽然笔者使用了附加注意,但也提出了改进,这种改进提升了注意方式。不收录要考虑的上下文信息基于上一期的信息模型,让我们看一下他是如何做到的:设置LSTM的输出维度,以及标题和通过相应LSTM进行查询的输出矩阵。

要了解注意力,首先要了解的是注意力的对象和基础。显然,在构造时,我们正在为查询中的LSTM输出之后的每个节点进行计算,因此该公式意味着对于查询中的每个单词,请注意标题的表示形式并获得分数。另外,它是在计算中引入的,目的是在步骤t-1之前添加模型的主要焦点信息。当然,注意力只是信息的调整。最后,必须考虑并汇总原创信息,因此有:

其中是LSTM之后查询的最终输出。您得到的是这次将查询发送到完全连接的层之前的表单。

请注意,我们发现除了计算得出的总和之外,我们还考虑了更多问题。作者给出的解释是为了提高分类的效果。具体的表现形式在于上述查询和项目之间的“多重”。在考虑查询中的每个位置与注意中的整体标题之间的关系之后,计算“一对一”的关系。通过参数训练,它实际上可以表示具有统一表达能力的整批与标题相关的查询。时间可以反映出这种所谓的“统一表达”与特定查询之间的差距。最后,当然是损失函数:

其中一个是可调整阳性样品重量的超参数。在本文中,我们将更加关注正样本(无与伦比),因此。 4、文本生成器搜索引擎下的正样本(不匹配)非常简单,但是要找到与相应标题不匹配但与对应查询相似的文本,这就是我们所说的“对抗样本”,确实不容易,我们希望找到对抗性实例来协助训练,从而提高模型的鲁棒性。在文章中,作者使用VED-变体编解码器。我们希望输入可以产生一个。这不匹配,但是非常接近(实际上,在某种程度上可以理解,我们将挖掘相似性分类的“决策边界”)。作者本人并未对VED进行很多改进,而是直接遵循了(Bahuleyan等,201 7) [7]的操作,其特定格式变得非常简单:

5、生成器和查询之间的链接

由于内部实际上涉及两个任务:分类和生成,为了使这两个端到端整体成立,有必要涉及一个统一的损失函数,权衡这两个函数,以便使两个函数都能达到最佳状态尽可能同时。返回并查看整个模型架构,尤其是橙色部分:

在这里,总和是分别通过查询LSTM的查询结果和生成的查询的结果,这是满足概率的伯努利分布。展开以查看此公式的原理。首先,如果查询本身与标题不相似,即在整个公式中仅使用原创查询。相反,如果查询被完全使用,则使用生成的查询。为了产生一定量的噪声,引入了随机数。 6、损失函数设计,训练分类和生成的双重任务,然后应仔细考虑两者的联合学习。因此,作者设计了这样一个公式:

请仔细查看此公式是否类似于上面的公式(3)?简单地说,只有当查询和标题非常相似时(负示例),才会考虑生成器生成的查询和标题。但是,实际上,我们可以发现上述损失函数,无论是查看查询还是生成的查询,都只是在分析它们与文档之间的差异,换句话说,考虑了“正样本”,但是存在没有否定样本,他们实际上是怎么做的?让我们看一下他们的训练过程。

在训练过程中,首先要做的是训练第一轮分类器,然后使用分类器对相似和不相似的查询进行划分,然后使用此数据来训练VED的第一个版本。在此基础上,使用公式(4)作为损失进行调整,最后得到所需的模型,尤其是该分类模型。

3

实验和结果具有基本模型和一定的理论基础,当然,我们必须开始实践这一内容。作者正在设计用于电子商务搜索。当然,有必要使用电子商务数据进行实验。实验数据量将达到320万对,其中只有少量是不匹配的。这里的“匹配”是指查询查询以后经常购买的那些产品的标题。 1、模型效果

以gbdt作为基准(老实说,我不太同意使用gbdt作为基准。从我的角度来看,语义相似性不是主流,而dssm是更著名的基准)。可以看出,从这个角度来看,即使只有分类器,作者的模型效果甚至比著名的bert还要高。得到了进一步的改善。离线评估的效果令人欣喜,QUARTS在网上也取得了不错的表现。经过两个国家的A / B测试,与当前基准相比,它分别增加了1 2. 2%和5. 75%。 2、生成器的效果,根据作者的分析,实际准确率可以达到82%,这是一个不错的水平,让我们来看一些情况:

可以看出,正如作者所期望的,该查询与所生成的查询具有高度的相似性,同时可以满足与相应标题的关系。

4

结论和展望阅读文章之后,我们要做的当然是吸收在文章中提到和提出的一些建模技巧:让我感到更加惊讶的是,我坐下了,bert。并且损失了很多,但这主要是因为BERT是基于DSSM的改进。实际上,您可以尝试用bert替换在此模型下经过训练的标题嵌入和查询嵌入。估计会有新的改进(但是模型估计更大)。因此,让我为您提供一些可以尽可能改进的想法(请记住,下一个最高职位将是您的)。此外,我也想提到一点,就是在bert操蛋的时候,这个模型是除了LSTM之外,它本身没有复杂的操作,并且估计耗时约为10毫秒。参考文献:

[1] SIGIR2018的报告谈到了该领域的语义匹配模型:〜hexn / papers / sigir18-tutorial-deep-matching.pdf

[2]使用点击数据学习用于网络搜索的深度结构化语义模型:

[3]学习用于电子商务产品搜索的可靠模型:

[4]冒险:针对文本蕴涵性的对抗训练,并附有知识指导的示例:

[5]与神经注意有关的必然性:

[6]通过共同学习对齐和翻译来进行神经机器翻译。

[7]序列间模型的差异关注:〜ppoupart / publications / conversational-agents / variational-attention-sequence.pdf

招聘

AI Technology Review希望招聘一名技术编辑/记者

办公地点:北京/深圳

职位:主要参加学术会议报告和个人访谈

工作内容:

1、参加各种人工智能学术会议并报告会议内容;

2、对人工智能领域的学者或研发人员的采访;

3、关注学术领域的热点事件,并及时跟进和汇报。

要求:

1、喜欢人工智能的学术研究内容,并且善于与学者或公司工程师打交道;

2、具有一定的科学和工程背景,并且对人工智能技术有一定了解的人会更好;

3、较强的英语水平(工作涉及很多英语材料);

4、较强的学习能力,对尖端的人工智能技术有一定的了解,并可以逐步形成自己的见解。

如果您有兴趣,可以将简历发送到邮箱:

短视频,自媒体,达人种草一站(组图)

网站优化 • 优采云 发表了文章 • 0 个评论 • 130 次浏览 • 2021-05-15 02:03

短视频自媒体,为人们种草提供一站式服务

网站上的八个SEO优化点:

首先,目标网页的内容是解决问题,而不仅仅是描述问题

例如,当某人搜索“用于结婚的衣服”时,最佳页面内容应指向以下几个方面:[20个推荐给男性客人的婚礼搭配]和[选择的搭配购买信息]。由于此搜索词后面的用户猜测他要参加婚礼,因此,解决该问题的最终方法是在哪里买衣服,而不是让他学习如何搭配衣服。因此,在优化此关键词时,我们的内容应满足他的最终需求,以便更好地进行排水和转化。

第二,重要的事情说了三遍“装载速度,速度,速度”

在信息分散的时代,没有人愿意给您等待的机会,因此网站的打开和加载速度比任何优化点都重要。打开时间越短,用户满意度就越高。搜索引擎也是如此。因此,当出现优化时,请考虑可以采取哪些措施来加快速度,例如CDN,无用代码删除,服务器宽带升级,缓存,页面精简,纯静态页面和其他优化操作。

第三,增强用户界面,用户体验和品牌以获得信任和参与。

打开网站后,许多用户都会有第一印象,一个好的小屋,一个好的本地乌龟,而且如此专业并不是我们想要的结果。页面设计需要用户界面和用户体验投资以及品牌自己的口碑认可,否则用户将很难有信任感和参与感网站。最实用的方法是参考行业中更好的网站来模仿,购买网站模板的付费版本,或让用户参与每个设计过程。

第四,避免导致用户离开页面的各种因素

许多弹出窗口,固定凸窗和广告空间会让用户感到恶心,并放弃整个浏览过程。这是在优化过程中应避免和删除的部分。考虑使用更多本地方法植入这些元素或奖励用户完成该过程。同时,在使用代码时,避免蜘蛛被搜索引擎禁止或难以捕捉和降级的可能性。

五,关键词植入

应该继续进行常规的关键词植入,例如文章中的标题,H1,关键词,外部链接锚文本,内部链接锚文本,图片ALT,URL,图片命名等。我不会对此有更多了解,每个人都可以理解。

六,主题模型的注入。

仅填充#5个单词是不够的,因为如果过于机械化,它将失去文本用户的体验。因此,我们必须制作一个主题模型,例如关键词。[婚礼礼服匹配]我们可以扩展到燕尾服,婚礼礼服,婚礼背心,婚礼服,婚宴和其他相关单词。作为一个大主题,此类页面内容将使关键词排名更加全面,并有助于更多用户。同时,搜索引擎可以解释您要推送的主题内容与婚纱有关。

显示文字的七个深度优化

排名显示的信息对于点击率非常重要,因此我们可能必须影响显示的信息(主要是标题,desc,url)。这些元素的内容需要优化:标题的创造力,desc的流行度,URL的规范,文章日期,结构化数据的使用,在线对话等。

八,创造独特的有价值的内容

归根结底,市场营销无法逃避内容质量。好的内容包括:

1)提供独特的视觉体验,前端界面,适当的字体和功能按钮。

2)内容必须具有高价值,高信誉,有趣且值得采集。

3)与其他内容相比,没有重复,而且深度更深。

4)快速打开(无广告),并且可以在不同的终端上阅读。

5)可以产生情感想法,例如认同,惊奇,幸福,思考等。

6)可以达到一定的转发和传播能力。

7)可以使用完整,准确和独特的信息来解决或回答问题。 查看全部

短视频,自媒体,达人种草一站(组图)

短视频自媒体,为人们种草提供一站式服务

网站上的八个SEO优化点:

首先,目标网页的内容是解决问题,而不仅仅是描述问题

例如,当某人搜索“用于结婚的衣服”时,最佳页面内容应指向以下几个方面:[20个推荐给男性客人的婚礼搭配]和[选择的搭配购买信息]。由于此搜索词后面的用户猜测他要参加婚礼,因此,解决该问题的最终方法是在哪里买衣服,而不是让他学习如何搭配衣服。因此,在优化此关键词时,我们的内容应满足他的最终需求,以便更好地进行排水和转化。

第二,重要的事情说了三遍“装载速度,速度,速度”

在信息分散的时代,没有人愿意给您等待的机会,因此网站的打开和加载速度比任何优化点都重要。打开时间越短,用户满意度就越高。搜索引擎也是如此。因此,当出现优化时,请考虑可以采取哪些措施来加快速度,例如CDN,无用代码删除,服务器宽带升级,缓存,页面精简,纯静态页面和其他优化操作。

第三,增强用户界面,用户体验和品牌以获得信任和参与。

打开网站后,许多用户都会有第一印象,一个好的小屋,一个好的本地乌龟,而且如此专业并不是我们想要的结果。页面设计需要用户界面和用户体验投资以及品牌自己的口碑认可,否则用户将很难有信任感和参与感网站。最实用的方法是参考行业中更好的网站来模仿,购买网站模板的付费版本,或让用户参与每个设计过程。

第四,避免导致用户离开页面的各种因素

许多弹出窗口,固定凸窗和广告空间会让用户感到恶心,并放弃整个浏览过程。这是在优化过程中应避免和删除的部分。考虑使用更多本地方法植入这些元素或奖励用户完成该过程。同时,在使用代码时,避免蜘蛛被搜索引擎禁止或难以捕捉和降级的可能性。

五,关键词植入

应该继续进行常规的关键词植入,例如文章中的标题,H1,关键词,外部链接锚文本,内部链接锚文本,图片ALT,URL,图片命名等。我不会对此有更多了解,每个人都可以理解。

六,主题模型的注入。

仅填充#5个单词是不够的,因为如果过于机械化,它将失去文本用户的体验。因此,我们必须制作一个主题模型,例如关键词。[婚礼礼服匹配]我们可以扩展到燕尾服,婚礼礼服,婚礼背心,婚礼服,婚宴和其他相关单词。作为一个大主题,此类页面内容将使关键词排名更加全面,并有助于更多用户。同时,搜索引擎可以解释您要推送的主题内容与婚纱有关。

显示文字的七个深度优化

排名显示的信息对于点击率非常重要,因此我们可能必须影响显示的信息(主要是标题,desc,url)。这些元素的内容需要优化:标题的创造力,desc的流行度,URL的规范,文章日期,结构化数据的使用,在线对话等。

八,创造独特的有价值的内容

归根结底,市场营销无法逃避内容质量。好的内容包括:

1)提供独特的视觉体验,前端界面,适当的字体和功能按钮。

2)内容必须具有高价值,高信誉,有趣且值得采集。

3)与其他内容相比,没有重复,而且深度更深。

4)快速打开(无广告),并且可以在不同的终端上阅读。

5)可以产生情感想法,例如认同,惊奇,幸福,思考等。

6)可以达到一定的转发和传播能力。

7)可以使用完整,准确和独特的信息来解决或回答问题。

短视频,自媒体,达人种草一站服务搜索引擎(SEO)优化怎么做

网站优化 • 优采云 发表了文章 • 0 个评论 • 127 次浏览 • 2021-05-14 22:03

短视频自媒体,为人们种草提供一站式服务

如何进行搜索引擎(SEO)优化,以及搜索引擎优化中收录哪些特定方面。

一、域名优化,选择一个较短的域名,收录关键词的域名,并启用ssl协议。

二、主机优化,选择稳定可靠的主机,建议选择阿里云和腾讯云主机。

三、 URL优化,静态URL设置,并尝试缩短URL的长度,URL级别越浅,就越有益收录。

四、空间优化,国内网站选择国内空间,国外空间选择国外主机。

五、模板优化,选择美观的模板以改善用户体验,然后选择带有简单代码的模板。

六、 网站标题优化,知道如何编写网站标题,知道如何编写出色的网站(标题)标题。

七、 文章标题优化,文章标题不能与关键词堆叠在一起,也不能为了获得流量而放弃用户体验。

八,长尾巴关键词优化,注意长尾巴关键词,并准备对长尾巴关键词进行更新。

九、 关键词密度优化,无论是网站主页还是内页,都必须确保合理的关键词密度。

十、外部链优化,为网站添加外部链,并确保外部链的质量,数量和不断更新。

十个一、 网站更新,新的站点需要更新,旧的站点也需要连续更新,并根据竞争对手进行更新。

通过301重定向将十个二、 301重定向,统一的网站权重和网站权重采集到相同的域名。

十个三、内部链优化,网站不仅需要外部链优化,还需要内部链优化。

搜索引擎优化还包括网站日志诊断,导航优化,内容质量优化等。 查看全部

短视频,自媒体,达人种草一站服务搜索引擎(SEO)优化怎么做

短视频自媒体,为人们种草提供一站式服务

如何进行搜索引擎(SEO)优化,以及搜索引擎优化中收录哪些特定方面。

一、域名优化,选择一个较短的域名,收录关键词的域名,并启用ssl协议。

二、主机优化,选择稳定可靠的主机,建议选择阿里云和腾讯云主机。

三、 URL优化,静态URL设置,并尝试缩短URL的长度,URL级别越浅,就越有益收录。

四、空间优化,国内网站选择国内空间,国外空间选择国外主机。

五、模板优化,选择美观的模板以改善用户体验,然后选择带有简单代码的模板。

六、 网站标题优化,知道如何编写网站标题,知道如何编写出色的网站(标题)标题。

七、 文章标题优化,文章标题不能与关键词堆叠在一起,也不能为了获得流量而放弃用户体验。

八,长尾巴关键词优化,注意长尾巴关键词,并准备对长尾巴关键词进行更新。

九、 关键词密度优化,无论是网站主页还是内页,都必须确保合理的关键词密度。

十、外部链优化,为网站添加外部链,并确保外部链的质量,数量和不断更新。

十个一、 网站更新,新的站点需要更新,旧的站点也需要连续更新,并根据竞争对手进行更新。

通过301重定向将十个二、 301重定向,统一的网站权重和网站权重采集到相同的域名。

十个三、内部链优化,网站不仅需要外部链优化,还需要内部链优化。

搜索引擎优化还包括网站日志诊断,导航优化,内容质量优化等。

|基于主题的网页实时分类模型的研究红

网站优化 • 优采云 发表了文章 • 0 个评论 • 119 次浏览 • 2021-05-14 21:34

-1-中国科技论文在线基于主题的网页实时分类模型研究马建宏,张晨光*作者简介:马建宏,(1965-),女,教授,主要研究方向:人工智能,软件工程。 (河北工业大学计算机科学与软件学院,天津30040 0)摘要:本文首先研究了通用分类模型,并分析了该模型对网页进行实时分类的5个缺点。在此基础上,为了提高适用于网页的实时分类的效果,提出了一种基于主题的网页分类模型:首先,通过Nutch构建垂直搜索引擎的主题爬虫,该抓取器可以始终在Internet上进行爬网,以确保网页的实时性。网页的实时性质;然后遍历主题噪声处理Nutch的爬网结果,并删除一些与分类无关的页面,最后,对爬网的网页进行分类,实验表明,通过该模型,网页分类的速度和准确性针对网页实时分类的大数据需求,该模型可以有效地优化10个输入sam ples并节省计算时间。 关键词:计算机应用技术;话题;分类;实时分类。中文地图分类号:基于15个主题的实时网页分类研究马建宏,张晨光(河北工业大学计算机科学与软件工程学院,天津30040 0)摘要:本文,一般分类首先研究模型,并在此基础上分析通用模型实时分类的不足之处,针对20种更适合实时分类的模型,提出了一种基于分类的模型,构建了垂直搜索引擎的主题。通过Nutch进行爬虫,并且可以一直对网页进行爬网,因此可以通过主题结尾处理Nutch的爬网结果来确保实时,部分删除与分类无关的网页可以通过实验25进行爬取,结果表明,根据实时的网页分类大数据需求,可以提高速度和准确性,该模型可以有效地优化合并输入样本并节省计算时间。关键词:计算机应用技术;计算机辅助设计主题;分类;实时分类30 0简介随着Internet技术的迅猛发展,Internet上的信息量急剧增加。同时,网页的数量也呈指数增长。

但是,由于信息的复杂性,用户越来越难以迅速地及时找到和获取信息。结果,网页分类技术逐渐发展。网页分类技术可以对网页进行自动,快速的分类,在当前的热门搜索领域和推荐系统中具有重要的应用价值和发展前景。 35网页分类系统主要分为4个主要模块:网页预处理,特征提取和权重分布,特征选择和分类器[1]。目前,国内科研人员已经对每个模块进行了详细的研究。在网页预处理和特征选择方面,熊忠阳等。使用布隆过滤器算法确定获得的特征指纹的相似性,并提出了一种新的大规模网络重复数据删除算法[2]。周其年等。提出了一种基于词的特征选择方法[3]。就实现分类器而言,K最近邻算法(KNN)目前被证明是用于网页分类的最佳算法,并且已经进行了深入研究。 40其中,黄建华等。考虑样本的分布,并提出了局部加权的Citation-KNN算法[4];陆峰等。提出了一种模糊证据KNN分类方法[5]。由KNN算法实现的分类模型通常分为训练过程和测试过程。该模型具有较高的分类精度和较短的训练时间,但也存在一定的缺陷。当类别的数量相对较大时,由于主题分散,因此需要庞大的语料库。计算量巨大,不利于网页的实时分类。

本文提出了一种基于主题的分类模型,通过45 Nutch为垂直搜索引擎构建了主题采集器,并提出了一种用于主题去噪的预处理方案,优化了输入样本,并设计了一种更适合实际使用的模型网页的时间分类。 1网页分类模型通用分类模型KNN分类模型的基本思想是首先对文件的一部分进行预处理,提取特征,转换文本向量,并进行分类标注以形成训练样本;然后,当测试样本到达时,执行和训练样本的处理类似;最后,它们由KNN分类器分类。过程如下图所示:图1-1通用分类模型55通过KNN分类模型的过程,我们可以看到在对网页进行分类时,每个测试样本必须与训练样本一起计算。对于大量样本数据集,由于要分类的样本包括广泛的类别,因此,如果您对网页进行实时分类,则会发现计算量很大;此外,在实时分类中有很多嘈杂的样本。这些将导致分类速度慢和分类精度低。为了解决这些问题,本文对模型进行了改进。改进的分类模型60通过研究和分析,可以看出网页的分类准确性和速度与要分类的网页的质量密切相关。待分类的网页的质量可以定义为:在实时分类网页的过程中,如果待分类的网页明确属于训练样本中的某个类别,则该网页的质量为高质量的网页。 如果要分类的网页属于广告或非培训样本,则如果您专注于某类网页,则该网页是低质量网页。

很明显,对网页进行实时分类的关键是如何优化测试样本并获得一批高质量的输入样本。 65基于以上观点,可以如下改进KNN分类模型,如图所示:图1-2改进的分类模型主要技术主题捕获70通过垂直搜索可以很好地理解“主题”的概念引擎。垂直搜索引擎[6]是特定行业的专业搜索引擎。它是搜索引擎的细分和扩展。它是网页库中特定类型专业信息的集成。每个垂直搜索引擎都有自己的“主题”,它指向特定类别的信息。本文借用主题的概念来执行“主题爬网”,即从Internet上爬网特定类别的网页。例如,本文将以“科学技术”为主题,并通过nutch的采集和主题确定[7]形成“主题抢夺”,最终得到大量的75-3-篇中国科技论文。在线科学技术网页(其中将收录一些嘈杂的网页)。目前,用于信息采集的主要工具是nutnut和hritrix。本文使用小结来捕捉主题。通过注入url种子链接,采集可以到达许多网页地址(CrawlDB)和反向链接地址(LinkDB)。基本上,从图1-3到图1-4的转换可以通过主题捕获来实现。 80图1-3改进的分类模型图1-4改进的分类模型85在该图中,圆圈代表技术类别下的类别A,矩形代表技术类别下的类别B,三角形代表以下网页:与技术类别无关。

可以看出,通过主题爬网,可以将大多数与分类无关的页面排除在外。但是,获得的页面仍将与一些低质量的页面混合在一起,这也是影响分类准确性和速度的主要原因。主题降噪在主题捕获后必须实时分类但与分类无关的所有这些页面都被分类为90噪声级。在网页预处理中,存在网页去噪的概念[8],即删除与网页中的分类无关的信息,例如广告,导航栏等。在这里可以借用此概念来定义主题降噪:所谓的主题降噪是从获取的数据集中删除与主题无关的网页。分析表明,坚果的爬行结果将存储在不同的位置。其中,CrawlDB主要存储爬网页面的URL地址,LinkDB主要存储这些URL地址的反向链接地址。 95 Google的排名算法是著名的PageRank算法。它的主要思想是“高质量的页面A链接到页面B,那么页面B更有可能是高质量的页面”。它使用链接对页面进行评分,然后完成排序。反向链接是其算法的核心。反向链接的定义如下:页面C收录指向页面D的名为“ C-D”的链接,然后对于D,此“ C-D”是反向链接。 100在上述理论支持下,我们可以做出以下假设:“当主题降噪时,如果存在MN,则为了确定第N页是否是无关页面,可以通过其反向链接页面M来确定;如果M是垃圾网页,例如广告,可以排除N”。

这样,可以排除与推荐页面无关的许多页面,同时减少了分类过程中的计算时间,提高了分类效率。主题降噪流程图如下图2-3所示。4-中文科技论文在线105图1-5主题降噪流程图在判断url是否为广告页面时,可以使用url的特征。在实验中,采集访问了许多科技网站的网页,并从CrawlDB中发现其中一些是淘宝下的页面,有些属于搜狐下的运动模块。根据URL的特性,可以使用52个反向链接删除具有该URL的页面,这证明110个主题降噪可以有效消除不相关的页面,例如广告。 KNN分类算法KNN(k-Nearest Neighbor)分类算法,即K最近邻分类算法,是一个发展已久的理论上成熟的方法[9]。这种方法的实现思路是:假设我们有一个样本A,如果它最接近的K个样本中的大多数都属于某个类别M,则我们将样本A归为M类别。其中,A的K个邻居中有115个指定了他们的类别。 KNN算法的决策过程是基于最新的一个或几个样本的类别来确定要分类的样本的类别。当K = 1时,要分类的样本属于最近样本的类别。

KNN算法的决策过程如下图所示:图1-6 KNN算法的决策过程120-5-分配给绿色圆圈,是红色三角形还是蓝色正方形?如果K = 3,则由于红色三角形的比例为2/3,因此将为绿色圆圈指定红色三角形的类别;如果K = 5,则由于蓝色正方形的比例为3/5,因此将为绿色圆圈分配那种蓝色正方形。 KNN算法的实现步骤如下:125 1)预处理期望的库网页以形成网页向量V(v1,v2,v3 ... vi)。 2)在测试网页上执行分词和特征提取,以形成网页向量U(u1,u2,u3 ... ui)。 3)计算要分类的样本和训练样本之间的相似度。计算公式为:(,)sim uv = 21()nii iu v = -∑ 4)从小到大对相似度进行排序,选择前K个页面。目前,K的值没有定性值。随着实验的进行,它需要不断变化以选择最合适的K值。5)在所选的K个网页中,分别计算每个类别要分类的样本的次数,计算公式为:(, )jp uc = 1(,)(,)ki jisim uvyvc = ∑其中(,)jp uc = 1(,)(,)ki jisim uvyvc = ∑其中(,)jp uc = 1(,)(,)ki jisim uvyvc = ∑)i jy vc是类别属性函数。当vi属于cj时,值为1;当vi属于cj时,值为1。当vi不属于cj时,该函数为0。

135 6)最终分类决策函数为max((,))j jRC c p v c =。 2实验过程和结果分析实验结构的设计分类模型有两个主要性能指标:精度和召回率[10]。计算公式可以表示为:m = m + rp =正确分类的样本数实际分类的样本数为140 q = mmn = +正确分类的样本数应为样本数在上式中,p表示准确率,m表示正确分类的类别,n表示该分类属于该类别并且没有正确分类,r表示该分类不属于该类别,并且被误分类为该类别。这两个绩效指标代表不同的方面。考虑到精度和召回率,可以获得一个新指标,即1F = 2pqp q +。此外,本文还将跟踪分类速度。在改进的分类模型的基础上,将本文的实验结构分为两部分进行实验。其中,主题捕获和145个主题确定部分采用Java语言并在eclipse编译平台上运行;分类器是用C ++编写的程序,而编译平台是Microsoft Visual C ++。使用十个URL(例如Sina和Yahoo)将种子注入种子,将挖掘深度depth设置为3,并且花费了30分钟和08秒来获得8372个URL。手动选择计算机科学,机械工程,生物工程,航空航天,化学工程和电气工程六个类别的150个新闻项目作为训练样本,并对其进行标记。

对受试者进行判断后,只获得了原创的8372页中的3008页作为第一组150个测试样本;然后,从8372页中重新获取3008页作为第二组测试样本。带有lucene的分词软件包IKAnalyzer用于预处理,TF方法用于根据词频选择特征词,KNN分类方法用于分类。几个实验表明,当K值为9时,分类效果更好。-6-在线实验结果和中国科技论文分析表1分类实验结果155第一组(改进模型)第二组(一般模型)类别P(%)q(%)F1测试时间(s)P(%)q(%)F1测试时间(s)计算机机械工程生物工程航空航天化工工程电气工程从实验结果出发,提出了改进的分类模型纸张的召回率和精确度都有所提高。 F1值略有增加;从分类时间的角度来看,改进模型的分类时间比普通模型的分类时间缩短了约18%。改进分类效果的原因是,对象捕获可以获取更多的目标输入样本,然后进行对象去噪处理,可以获得一批更适合训练样本分类的样本。 160 3结束语本文提出了一种更适合于网页的实时分类的分类模型-基于主题的分类模型。

实验证明,通过该模型,可以大大提高网页分类的速度和准确性。对于对网页进行实时分类的大数据需求,该模型可以有效地优化输入样本,节省计算时间,更适合于网页的实时分类。 165 [参考文献](参考文献)[1]段俊峰,黄伟通,卢玉昌。中文网页分类研究与系统设计(J)。计算机科学,2007,34(0 6):210-21 3. [2]熊忠洋,亚曼,张玉芳。一种基于网页主体结构和特征字符串的相似网页重复数据删除算法。计算机应用(J ),2013(0 2):554-55 7. [3]周其年,张振豪,徐登才。基于类别区分词的特征选择方法在中文文本分类中的应用(J)。计算机应用与软件,2013 (0 3):193-19 5. 170 [4]黄建华,丁建瑞,刘家峰。基于局部加权-kNN算法的引文(J)。电子与信息学报,2013(0 3) :627-63 2. [5]陆峰,杜妮,温成林。一种基于模糊证据的kNN分类方法(J)。电子学报,2012(1 2):2390-239 5. [6]吴彦伟,张琳。基于行业知识的垂直搜索引擎的研究与实现(D)。北京:北京邮电大学,201 2. [7]李东海,郝凤玲。主题s的实现基于Nutch技术的Earch引擎(D)。吉林:吉林大学,200 8. [8]朱学芳,冯锡熙。基于文本内容的农业网页信息提取与分类研究(J)。信息科学,2012(0 7):1012-101 5. 175 [9]何莉,贾艳。大规模层次分类问题的研究与进展(J)。计算机学报,2012(1 [k22) ]:2101-211 5. [10]张恒,屈景辉。网页文本信息的提取和结果评估(J)。微型计算机应用,2007(0 9):921-92 4. 查看全部

|基于主题的网页实时分类模型的研究红

-1-中国科技论文在线基于主题的网页实时分类模型研究马建宏,张晨光*作者简介:马建宏,(1965-),女,教授,主要研究方向:人工智能,软件工程。 (河北工业大学计算机科学与软件学院,天津30040 0)摘要:本文首先研究了通用分类模型,并分析了该模型对网页进行实时分类的5个缺点。在此基础上,为了提高适用于网页的实时分类的效果,提出了一种基于主题的网页分类模型:首先,通过Nutch构建垂直搜索引擎的主题爬虫,该抓取器可以始终在Internet上进行爬网,以确保网页的实时性。网页的实时性质;然后遍历主题噪声处理Nutch的爬网结果,并删除一些与分类无关的页面,最后,对爬网的网页进行分类,实验表明,通过该模型,网页分类的速度和准确性针对网页实时分类的大数据需求,该模型可以有效地优化10个输入sam ples并节省计算时间。 关键词:计算机应用技术;话题;分类;实时分类。中文地图分类号:基于15个主题的实时网页分类研究马建宏,张晨光(河北工业大学计算机科学与软件工程学院,天津30040 0)摘要:本文,一般分类首先研究模型,并在此基础上分析通用模型实时分类的不足之处,针对20种更适合实时分类的模型,提出了一种基于分类的模型,构建了垂直搜索引擎的主题。通过Nutch进行爬虫,并且可以一直对网页进行爬网,因此可以通过主题结尾处理Nutch的爬网结果来确保实时,部分删除与分类无关的网页可以通过实验25进行爬取,结果表明,根据实时的网页分类大数据需求,可以提高速度和准确性,该模型可以有效地优化合并输入样本并节省计算时间。关键词:计算机应用技术;计算机辅助设计主题;分类;实时分类30 0简介随着Internet技术的迅猛发展,Internet上的信息量急剧增加。同时,网页的数量也呈指数增长。

但是,由于信息的复杂性,用户越来越难以迅速地及时找到和获取信息。结果,网页分类技术逐渐发展。网页分类技术可以对网页进行自动,快速的分类,在当前的热门搜索领域和推荐系统中具有重要的应用价值和发展前景。 35网页分类系统主要分为4个主要模块:网页预处理,特征提取和权重分布,特征选择和分类器[1]。目前,国内科研人员已经对每个模块进行了详细的研究。在网页预处理和特征选择方面,熊忠阳等。使用布隆过滤器算法确定获得的特征指纹的相似性,并提出了一种新的大规模网络重复数据删除算法[2]。周其年等。提出了一种基于词的特征选择方法[3]。就实现分类器而言,K最近邻算法(KNN)目前被证明是用于网页分类的最佳算法,并且已经进行了深入研究。 40其中,黄建华等。考虑样本的分布,并提出了局部加权的Citation-KNN算法[4];陆峰等。提出了一种模糊证据KNN分类方法[5]。由KNN算法实现的分类模型通常分为训练过程和测试过程。该模型具有较高的分类精度和较短的训练时间,但也存在一定的缺陷。当类别的数量相对较大时,由于主题分散,因此需要庞大的语料库。计算量巨大,不利于网页的实时分类。

本文提出了一种基于主题的分类模型,通过45 Nutch为垂直搜索引擎构建了主题采集器,并提出了一种用于主题去噪的预处理方案,优化了输入样本,并设计了一种更适合实际使用的模型网页的时间分类。 1网页分类模型通用分类模型KNN分类模型的基本思想是首先对文件的一部分进行预处理,提取特征,转换文本向量,并进行分类标注以形成训练样本;然后,当测试样本到达时,执行和训练样本的处理类似;最后,它们由KNN分类器分类。过程如下图所示:图1-1通用分类模型55通过KNN分类模型的过程,我们可以看到在对网页进行分类时,每个测试样本必须与训练样本一起计算。对于大量样本数据集,由于要分类的样本包括广泛的类别,因此,如果您对网页进行实时分类,则会发现计算量很大;此外,在实时分类中有很多嘈杂的样本。这些将导致分类速度慢和分类精度低。为了解决这些问题,本文对模型进行了改进。改进的分类模型60通过研究和分析,可以看出网页的分类准确性和速度与要分类的网页的质量密切相关。待分类的网页的质量可以定义为:在实时分类网页的过程中,如果待分类的网页明确属于训练样本中的某个类别,则该网页的质量为高质量的网页。 如果要分类的网页属于广告或非培训样本,则如果您专注于某类网页,则该网页是低质量网页。

很明显,对网页进行实时分类的关键是如何优化测试样本并获得一批高质量的输入样本。 65基于以上观点,可以如下改进KNN分类模型,如图所示:图1-2改进的分类模型主要技术主题捕获70通过垂直搜索可以很好地理解“主题”的概念引擎。垂直搜索引擎[6]是特定行业的专业搜索引擎。它是搜索引擎的细分和扩展。它是网页库中特定类型专业信息的集成。每个垂直搜索引擎都有自己的“主题”,它指向特定类别的信息。本文借用主题的概念来执行“主题爬网”,即从Internet上爬网特定类别的网页。例如,本文将以“科学技术”为主题,并通过nutch的采集和主题确定[7]形成“主题抢夺”,最终得到大量的75-3-篇中国科技论文。在线科学技术网页(其中将收录一些嘈杂的网页)。目前,用于信息采集的主要工具是nutnut和hritrix。本文使用小结来捕捉主题。通过注入url种子链接,采集可以到达许多网页地址(CrawlDB)和反向链接地址(LinkDB)。基本上,从图1-3到图1-4的转换可以通过主题捕获来实现。 80图1-3改进的分类模型图1-4改进的分类模型85在该图中,圆圈代表技术类别下的类别A,矩形代表技术类别下的类别B,三角形代表以下网页:与技术类别无关。

可以看出,通过主题爬网,可以将大多数与分类无关的页面排除在外。但是,获得的页面仍将与一些低质量的页面混合在一起,这也是影响分类准确性和速度的主要原因。主题降噪在主题捕获后必须实时分类但与分类无关的所有这些页面都被分类为90噪声级。在网页预处理中,存在网页去噪的概念[8],即删除与网页中的分类无关的信息,例如广告,导航栏等。在这里可以借用此概念来定义主题降噪:所谓的主题降噪是从获取的数据集中删除与主题无关的网页。分析表明,坚果的爬行结果将存储在不同的位置。其中,CrawlDB主要存储爬网页面的URL地址,LinkDB主要存储这些URL地址的反向链接地址。 95 Google的排名算法是著名的PageRank算法。它的主要思想是“高质量的页面A链接到页面B,那么页面B更有可能是高质量的页面”。它使用链接对页面进行评分,然后完成排序。反向链接是其算法的核心。反向链接的定义如下:页面C收录指向页面D的名为“ C-D”的链接,然后对于D,此“ C-D”是反向链接。 100在上述理论支持下,我们可以做出以下假设:“当主题降噪时,如果存在MN,则为了确定第N页是否是无关页面,可以通过其反向链接页面M来确定;如果M是垃圾网页,例如广告,可以排除N”。

这样,可以排除与推荐页面无关的许多页面,同时减少了分类过程中的计算时间,提高了分类效率。主题降噪流程图如下图2-3所示。4-中文科技论文在线105图1-5主题降噪流程图在判断url是否为广告页面时,可以使用url的特征。在实验中,采集访问了许多科技网站的网页,并从CrawlDB中发现其中一些是淘宝下的页面,有些属于搜狐下的运动模块。根据URL的特性,可以使用52个反向链接删除具有该URL的页面,这证明110个主题降噪可以有效消除不相关的页面,例如广告。 KNN分类算法KNN(k-Nearest Neighbor)分类算法,即K最近邻分类算法,是一个发展已久的理论上成熟的方法[9]。这种方法的实现思路是:假设我们有一个样本A,如果它最接近的K个样本中的大多数都属于某个类别M,则我们将样本A归为M类别。其中,A的K个邻居中有115个指定了他们的类别。 KNN算法的决策过程是基于最新的一个或几个样本的类别来确定要分类的样本的类别。当K = 1时,要分类的样本属于最近样本的类别。

KNN算法的决策过程如下图所示:图1-6 KNN算法的决策过程120-5-分配给绿色圆圈,是红色三角形还是蓝色正方形?如果K = 3,则由于红色三角形的比例为2/3,因此将为绿色圆圈指定红色三角形的类别;如果K = 5,则由于蓝色正方形的比例为3/5,因此将为绿色圆圈分配那种蓝色正方形。 KNN算法的实现步骤如下:125 1)预处理期望的库网页以形成网页向量V(v1,v2,v3 ... vi)。 2)在测试网页上执行分词和特征提取,以形成网页向量U(u1,u2,u3 ... ui)。 3)计算要分类的样本和训练样本之间的相似度。计算公式为:(,)sim uv = 21()nii iu v = -∑ 4)从小到大对相似度进行排序,选择前K个页面。目前,K的值没有定性值。随着实验的进行,它需要不断变化以选择最合适的K值。5)在所选的K个网页中,分别计算每个类别要分类的样本的次数,计算公式为:(, )jp uc = 1(,)(,)ki jisim uvyvc = ∑其中(,)jp uc = 1(,)(,)ki jisim uvyvc = ∑其中(,)jp uc = 1(,)(,)ki jisim uvyvc = ∑)i jy vc是类别属性函数。当vi属于cj时,值为1;当vi属于cj时,值为1。当vi不属于cj时,该函数为0。

135 6)最终分类决策函数为max((,))j jRC c p v c =。 2实验过程和结果分析实验结构的设计分类模型有两个主要性能指标:精度和召回率[10]。计算公式可以表示为:m = m + rp =正确分类的样本数实际分类的样本数为140 q = mmn = +正确分类的样本数应为样本数在上式中,p表示准确率,m表示正确分类的类别,n表示该分类属于该类别并且没有正确分类,r表示该分类不属于该类别,并且被误分类为该类别。这两个绩效指标代表不同的方面。考虑到精度和召回率,可以获得一个新指标,即1F = 2pqp q +。此外,本文还将跟踪分类速度。在改进的分类模型的基础上,将本文的实验结构分为两部分进行实验。其中,主题捕获和145个主题确定部分采用Java语言并在eclipse编译平台上运行;分类器是用C ++编写的程序,而编译平台是Microsoft Visual C ++。使用十个URL(例如Sina和Yahoo)将种子注入种子,将挖掘深度depth设置为3,并且花费了30分钟和08秒来获得8372个URL。手动选择计算机科学,机械工程,生物工程,航空航天,化学工程和电气工程六个类别的150个新闻项目作为训练样本,并对其进行标记。

对受试者进行判断后,只获得了原创的8372页中的3008页作为第一组150个测试样本;然后,从8372页中重新获取3008页作为第二组测试样本。带有lucene的分词软件包IKAnalyzer用于预处理,TF方法用于根据词频选择特征词,KNN分类方法用于分类。几个实验表明,当K值为9时,分类效果更好。-6-在线实验结果和中国科技论文分析表1分类实验结果155第一组(改进模型)第二组(一般模型)类别P(%)q(%)F1测试时间(s)P(%)q(%)F1测试时间(s)计算机机械工程生物工程航空航天化工工程电气工程从实验结果出发,提出了改进的分类模型纸张的召回率和精确度都有所提高。 F1值略有增加;从分类时间的角度来看,改进模型的分类时间比普通模型的分类时间缩短了约18%。改进分类效果的原因是,对象捕获可以获取更多的目标输入样本,然后进行对象去噪处理,可以获得一批更适合训练样本分类的样本。 160 3结束语本文提出了一种更适合于网页的实时分类的分类模型-基于主题的分类模型。

实验证明,通过该模型,可以大大提高网页分类的速度和准确性。对于对网页进行实时分类的大数据需求,该模型可以有效地优化输入样本,节省计算时间,更适合于网页的实时分类。 165 [参考文献](参考文献)[1]段俊峰,黄伟通,卢玉昌。中文网页分类研究与系统设计(J)。计算机科学,2007,34(0 6):210-21 3. [2]熊忠洋,亚曼,张玉芳。一种基于网页主体结构和特征字符串的相似网页重复数据删除算法。计算机应用(J ),2013(0 2):554-55 7. [3]周其年,张振豪,徐登才。基于类别区分词的特征选择方法在中文文本分类中的应用(J)。计算机应用与软件,2013 (0 3):193-19 5. 170 [4]黄建华,丁建瑞,刘家峰。基于局部加权-kNN算法的引文(J)。电子与信息学报,2013(0 3) :627-63 2. [5]陆峰,杜妮,温成林。一种基于模糊证据的kNN分类方法(J)。电子学报,2012(1 2):2390-239 5. [6]吴彦伟,张琳。基于行业知识的垂直搜索引擎的研究与实现(D)。北京:北京邮电大学,201 2. [7]李东海,郝凤玲。主题s的实现基于Nutch技术的Earch引擎(D)。吉林:吉林大学,200 8. [8]朱学芳,冯锡熙。基于文本内容的农业网页信息提取与分类研究(J)。信息科学,2012(0 7):1012-101 5. 175 [9]何莉,贾艳。大规模层次分类问题的研究与进展(J)。计算机学报,2012(1 [k22) ]:2101-211 5. [10]张恒,屈景辉。网页文本信息的提取和结果评估(J)。微型计算机应用,2007(0 9):921-92 4.

基于Nutch的农业信息搜索引擎的实现与优化

网站优化 • 优采云 发表了文章 • 0 个评论 • 130 次浏览 • 2021-05-14 07:46

[摘要]:随着Internet技术的不断发展,Internet上的知识和资源呈爆炸性增长。如何规范,有效地共享和管理这些资源是当前互联网面临的关键问题,也是下一代。 Web的主要研究方向。针对这种情况,知识网格技术应运而生。 Knowledge Grid的研究目标是建立一个基于下一代Web的有效共享和管理知识,信息和资源的平台。本文实现了基于开源搜索引擎Nutch的农业信息搜索引擎系统,并改进和优化了该系统的缺点。本文的工作是国家863项目“数字农业知识网格技术研究与应用”中知识问答系统的一部分。它实现了互联网上农业信息的采集和检索,为地方知识库的建设和扩展提供了丰富的信息。资源。本文的具体内容:(1)介绍了本文的研究背景,研究目的和意义,并总结了一些有关搜索引擎优化的研究成果。(2)详细介绍了本文的背景知识。包括在搜索引擎上的工作详细介绍了其原理和架构,并对开源搜索引擎Nutch的总体架构进行了深入的分析和探索(3)实现了农业信息搜索引擎。在对搜索的深入理解的基础上基于开源搜索的搜索引擎技术引擎Nutch开发了一种农业信息搜索引擎系统。[4)针对该系统的某些缺陷进行了改进和优化。首先,改进了网页解析模块。本文使用基于STU-DOM树的网页主题信息提取方法在网页分析的基础上,实现了非主题信息的过滤基于语义属性值的节点。其次,对抽象提取模块的改进。本文基于统计的自动摘要提取方法增加了文本特征的判断能力,从词频,句型,提示词等方面对句子权重进行了更细致的分配。第三,查询扩展模块的实现。本文构建了农业领域本体,并在此基础上,利用耶拿推理机进行查询和搜索关键词。本体中,将相应的子类别,同义词和例句作为与搜索相关的词。本文开发的农业信息搜索引擎作为“数字农业知识网格”中知识问答系统的主要功能模块,实现了互联网。农业信息的搜集和检索也为建设和丰富农业信息提供了资源。当地的知识库。本文还比较了改进前后的效果。通过比较,我们发现门户网站类型的网页很多,并且搜索结果中收录大量链接。网页被过滤掉,其中大多数是基于文本的网页,用户可以从中直接获取信息。改进的摘要提取模块提取的摘要内容比以前提取的要多,摘要内容与网页主题的匹配程度更高。查询扩展模块提供与搜索词具有一定语义关系的搜索相关词,并为用户提供一种精确搜索的方式。 查看全部

基于Nutch的农业信息搜索引擎的实现与优化

[摘要]:随着Internet技术的不断发展,Internet上的知识和资源呈爆炸性增长。如何规范,有效地共享和管理这些资源是当前互联网面临的关键问题,也是下一代。 Web的主要研究方向。针对这种情况,知识网格技术应运而生。 Knowledge Grid的研究目标是建立一个基于下一代Web的有效共享和管理知识,信息和资源的平台。本文实现了基于开源搜索引擎Nutch的农业信息搜索引擎系统,并改进和优化了该系统的缺点。本文的工作是国家863项目“数字农业知识网格技术研究与应用”中知识问答系统的一部分。它实现了互联网上农业信息的采集和检索,为地方知识库的建设和扩展提供了丰富的信息。资源。本文的具体内容:(1)介绍了本文的研究背景,研究目的和意义,并总结了一些有关搜索引擎优化的研究成果。(2)详细介绍了本文的背景知识。包括在搜索引擎上的工作详细介绍了其原理和架构,并对开源搜索引擎Nutch的总体架构进行了深入的分析和探索(3)实现了农业信息搜索引擎。在对搜索的深入理解的基础上基于开源搜索的搜索引擎技术引擎Nutch开发了一种农业信息搜索引擎系统。[4)针对该系统的某些缺陷进行了改进和优化。首先,改进了网页解析模块。本文使用基于STU-DOM树的网页主题信息提取方法在网页分析的基础上,实现了非主题信息的过滤基于语义属性值的节点。其次,对抽象提取模块的改进。本文基于统计的自动摘要提取方法增加了文本特征的判断能力,从词频,句型,提示词等方面对句子权重进行了更细致的分配。第三,查询扩展模块的实现。本文构建了农业领域本体,并在此基础上,利用耶拿推理机进行查询和搜索关键词。本体中,将相应的子类别,同义词和例句作为与搜索相关的词。本文开发的农业信息搜索引擎作为“数字农业知识网格”中知识问答系统的主要功能模块,实现了互联网。农业信息的搜集和检索也为建设和丰富农业信息提供了资源。当地的知识库。本文还比较了改进前后的效果。通过比较,我们发现门户网站类型的网页很多,并且搜索结果中收录大量链接。网页被过滤掉,其中大多数是基于文本的网页,用户可以从中直接获取信息。改进的摘要提取模块提取的摘要内容比以前提取的要多,摘要内容与网页主题的匹配程度更高。查询扩展模块提供与搜索词具有一定语义关系的搜索相关词,并为用户提供一种精确搜索的方式。

主题搜索引擎中网络爬虫搜索策略的研究与实现

网站优化 • 优采云 发表了文章 • 0 个评论 • 109 次浏览 • 2021-05-14 07:27

[摘要]:主题网络采集器是一个自动代码程序,可从主题搜索引擎的后端获取数据。在主题搜索引擎前端查询的数据已由主题Web采集器预先在Internet上进行了爬网,并存储在本地。然后从网页提取数据并建立索引。因此,主题采集器对主题搜索引擎起着辅助作用。本文提出了一种主题优先的爬虫算法,该算法结合了链接文本相关算法和主题信息值的遗传恢复算法来指导爬虫的爬虫方向,并采用PostgreSQL数据库集群技术存储数据。根据网页结构的特点,主题优先的爬行算法通过页面之间的主题转移来预测页面的主题相关性,解决了主题爬行器通道阻塞和爬行丢失的问题。首先,根据锚文本发送相关性信息值。如果锚文本给出的信息是相关的,则直接发送相关的阈值;否则,直接发送相关阈值。如果不相关,则将其乘以遗传基因比率后再进行传播。在传输过程中,如果遇到相关网页,则链接的相关信息的值恢复为初始值。相关性信息值根据不同的主题将Internet网页划分为不同的渠道。与主题相关的所有网页都位于最大的频道中,并且频道交错且连接在一起,并且爬网程序按照频道大小的顺序来抓取它们。采集器搜寻到的网页信息数量巨大,并且单个主机无法满足该信息的存储需求。本文在资源库和链接地址库中使用postgresql数据库集群技术来扩展后端存储容量。并在每个数据库点中使用pgbouncer连接池技术来减少数据库连接的数量并节省时间。在链接地址库中,缓存技术用于减少数据库操作的数量,减少时间消耗并提高采集器的速度。最后,通过实验测试和数据分析,验证了主题优先爬行技术的有效性以及基于PostgreSQL数据库集群技术的爬行系统的可行性。 查看全部

主题搜索引擎中网络爬虫搜索策略的研究与实现

[摘要]:主题网络采集器是一个自动代码程序,可从主题搜索引擎的后端获取数据。在主题搜索引擎前端查询的数据已由主题Web采集器预先在Internet上进行了爬网,并存储在本地。然后从网页提取数据并建立索引。因此,主题采集器对主题搜索引擎起着辅助作用。本文提出了一种主题优先的爬虫算法,该算法结合了链接文本相关算法和主题信息值的遗传恢复算法来指导爬虫的爬虫方向,并采用PostgreSQL数据库集群技术存储数据。根据网页结构的特点,主题优先的爬行算法通过页面之间的主题转移来预测页面的主题相关性,解决了主题爬行器通道阻塞和爬行丢失的问题。首先,根据锚文本发送相关性信息值。如果锚文本给出的信息是相关的,则直接发送相关的阈值;否则,直接发送相关阈值。如果不相关,则将其乘以遗传基因比率后再进行传播。在传输过程中,如果遇到相关网页,则链接的相关信息的值恢复为初始值。相关性信息值根据不同的主题将Internet网页划分为不同的渠道。与主题相关的所有网页都位于最大的频道中,并且频道交错且连接在一起,并且爬网程序按照频道大小的顺序来抓取它们。采集器搜寻到的网页信息数量巨大,并且单个主机无法满足该信息的存储需求。本文在资源库和链接地址库中使用postgresql数据库集群技术来扩展后端存储容量。并在每个数据库点中使用pgbouncer连接池技术来减少数据库连接的数量并节省时间。在链接地址库中,缓存技术用于减少数据库操作的数量,减少时间消耗并提高采集器的速度。最后,通过实验测试和数据分析,验证了主题优先爬行技术的有效性以及基于PostgreSQL数据库集群技术的爬行系统的可行性。

-87-信息产业1主题爬虫的个性化搜索引擎概述

网站优化 • 优采云 发表了文章 • 0 个评论 • 120 次浏览 • 2021-05-13 20:39

-87-信息产业1主题采集器的个性化搜索引擎概述1. 1个性化搜索引擎个性化搜索引擎既指界面的个性化,又指内容的个性化。基于个性化推荐服务的搜索引擎属于个性化搜索引擎的类别。界面个性化是为了向用户提供自定义搜索引擎的界面样式和布局功能,并根据用户的需求为用户提供预先定制的界面;内容个性化是为了使用户能够自定义搜索结果,而无需检索信息。有需要的用户即使使用相同的搜索词也将获得不同的匹配结果。显然,这里的重点是内容的个性化,其实际含义大于界面的个性化。 1. 2 Web爬网程序Web爬网程序,也称为蜘蛛程序(Spider)。 Web采集器是一个自动提取网页的程序,是搜索引擎的重要组成部分。网络蜘蛛通过网页的链接地址搜索网页。他们从网站中的某个页面(通常是主页)开始,读取网页的内容,在网页中找到其他链接地址,然后使用这些链接地址查找下一个网页。 ,因此循环将继续进行,直到此网站的所有网页都已被爬网。如果将Internet视为网站,则Spider可以使用此原理对Internet上的所有网页进行爬网。它在搜索引擎中占有重要地位,影响搜索引擎的检索和准确性,确定搜索引擎数据容量的大小,网络爬虫的质量直接影响搜索结果页面中的无效链接(即链接到搜索结果页面)。页数不存在。

1. 3 Web爬网程序在搜索引擎中的位置从上面搜索引擎的基本原理可以看出,Web爬网程序是一种可以跟踪Web上超链接结构并不断发现的网络爬虫。网络资源和采集程序。作为搜索引擎资源的一部分采集,网络采集器的性能将直接影响整个搜索引擎索引的网页的数量,质量和更新周期。 2基于主题采集器的个性化搜索引擎技术2. 1信息采集模型主题采集器基于普通的采集器,并通过在网页的整个处理过程中添加模块来实现个性化信息提取。这些模块包括主题确定模块,优化初始种子模块,主题相关性分析模块和排名模块。 (请参见图1)在图1中,有1个采集器模块检索了该网页。 2调用相关性分析模块以分析网页的相关性。 3爬行模块根据不同的分析结果进行相应的处理。 4爬网模块从数据库中获取等待处理的URL以继续工作,并循环到第一步,直到没有新的URL。 5排序网页的重要性。主题采集的关键是采集的结果与主题之间相似度的计算。可以通过相关的链接信息来预测结果为采集的相似度,以反映用户的个性化需求。 2. 2基于主题和用户个性化的爬网程序基于主题的爬网程序是选择性地搜索与预定义主题相关的页面的爬网程序。与基于整个Web的采集器相比,它不会采集与主题无关,节省硬件和网络资源的页面,并且由于数量很少而可以快速更新。

它还可以满足某些特定人群对特定领域信息的需求;基于用户个性化的采集器是一个轻量级的采集系统,其目标是引导用户的兴趣或与之互动。用户交互和其他方式来自采集信息,以向用户提供个性化服务。 2. 3超链接结构搜索策略基于链接结构的搜索策略的主要特征是使用Web结构信息来指导搜索,并通过分析Web页面之间的引用之间的关系来确定页面和链接的重要性。 。超链分析技术是主题搜索引擎使用的一种重要方法。下面将介绍几种重要的超链接分析算法。 2. 3. 1 PageRank算法PageRank算法是由斯坦福大学(Stanford University)(斯坦福大学)的Sergey Brin和Lawrence Page提出的。基本思想是:如果一个页面被许多其他页面引用,那么此页面很可能是重要页面;尽管该页面没有被多次引用,但是被一个重要页面引用了,那么该页面也可能是一个重要页面。重要页面;页面的重要性被平均划分并传递到它所引用的页面。页面重要性的量化分数是PageRank值。 Google的搜索引擎使用PageRank算法。网络中的超链接结构可以表示为有向图G =(V,E),其中V是节点(网页)的集合,E是边缘(当且仅当存在从第i页到第i页的链接时)在页面j中,在节点j)的边缘设置了一个从属节点i。假设页面u的链接网页为T1,T 2. .. Tn;参数d表示沿着该链接访问网页的“随机冲浪者”的衰减因子,取值范围为(0到1)之间,根据经验一般取值为0. 85。

C(Ti)表示从网页Ti链接到其他网页的链接数,PR(u)定义为网页u的链接权重。 PageRank值的计算公式为公式(1):其中e为1 / max,即max是所有网页的总和,分配给每个网页的初始权重是该总和的倒数。该算法的特征在于,指向网页的外部链接页面的页面级别越高,链接页面传递给网页的页面级别值就越高。因此,即使网页偶尔在内容中仅提及偏离查询主题的关键词语言,由于其较高的页面排名值,它也将获得相对较高的排名,这会影响搜索结果的相关性和相关性。精确。 2. 3. 2 HITS算法HITS算法由康奈尔大学的J. Kleinberg提出。 Kleinberg将网页分为两类,即集线器(中央级别)和权限(权限级别)。权威是具有较高价值的页面,并取决于指向它的页面,而集线器是指向更多权威并取决于它指向的页面的页面。 HITS算法的目标是通过某种计算方法(即具有最高排名的权威)来获取某个检索问题的最有价值的网页。但是,此算法在计算上比PageRank昂贵。而且它取决于用户的查询,实时性能很差。

此外,Authorities andhubs算法可能会出现“主题漂移”和“主题概括”现象。因此,“权威和中心”算法适用于各种主题的查询。 2. 3. 3 PageRank算法的改进。 PageRank算法的改进可以通过引入面向主题的思想并重新计算网页的链接关系来实现。首先,PageRank在发现页面重要性方面起着重要作用,但它并不针对某个特定主题(查询独立性)。这里,对PageRank方法进行了改进:在链接关系的基础上,增加了一定的语义信息权重,使得生成的重要页面针对某个主题,从而形成了SPageRank算法。 SPageRank算法不仅利用PageRank的优势来查找重要页面,而且还利用主题相关性。 2. 3. 4主题相关性算法搜索引擎的根源是传统的全文检索技术,并且搜索引擎遵循传统的信息检索模型。在用于计算文档相似度的传统算法中,Salton教授提出的向量空间模型是使用最广泛的算法。向量空间模型基于以下关键假设:组成文章的术语的出现顺序无关紧要,并且它们在文章主题中的作用彼此独立,因此可以将文档视为一系列无序条目的集合。

计算页面主题相关性的方法很多,例如NaiveBayes,神经网络,实例映射模型,向量空间模型(VSM)等。其中,向量空间模型对培训文档的要求较低。可以从少量的培训文档中提取出主要目标特征,计算简单,准确率高,更适合网络信息的发现。一种基于向量空间模型VSM的简单向量距离算法。该算法的基本思想是计算图2中两个向量之间的夹角的余弦值。VSM相似度的计算公式如公式(2):结论基于主题的个性化搜索引擎主要针对采集相关主题,并为用户提供个性化的信息服务。基于主题的采集的关键是计算采集的结果与主题之间的相似度。可以通过相关的链接信息来预测结果为采集的相似度,以反映用户的个性化需求。参考文献[1]高灵霞。基于主题爬虫的个性化搜索引擎技术分析[J]。计算机知识与技术.2009(32)[2]赵洪中李亚。垂直搜索引擎的应用研究[J]。现代商业工业。 2010(4)作者简介:陈晨(1989,5,11〜)女,汉族,哈尔滨大学工程学院,计算机科学与技术专业。基于主题爬虫的个性化搜索引擎技术研究陈晨(哈尔滨大学,哈尔滨15000,黑龙江0)摘要:基于主题爬虫的个性化搜索引擎技术借鉴了Web个性化推荐服务的思想,完善了Web表示搜索引擎的信息检索系统服务方法有效解决了互联网上“资源超载”和“信息丢失”的问题,相对满足了用户的需求。 关键词:主题采集器;搜索引擎;技术图1基于主题采集器的个性化信息采集模型图2 VSM模型图(2) 查看全部

-87-信息产业1主题爬虫的个性化搜索引擎概述

-87-信息产业1主题采集器的个性化搜索引擎概述1. 1个性化搜索引擎个性化搜索引擎既指界面的个性化,又指内容的个性化。基于个性化推荐服务的搜索引擎属于个性化搜索引擎的类别。界面个性化是为了向用户提供自定义搜索引擎的界面样式和布局功能,并根据用户的需求为用户提供预先定制的界面;内容个性化是为了使用户能够自定义搜索结果,而无需检索信息。有需要的用户即使使用相同的搜索词也将获得不同的匹配结果。显然,这里的重点是内容的个性化,其实际含义大于界面的个性化。 1. 2 Web爬网程序Web爬网程序,也称为蜘蛛程序(Spider)。 Web采集器是一个自动提取网页的程序,是搜索引擎的重要组成部分。网络蜘蛛通过网页的链接地址搜索网页。他们从网站中的某个页面(通常是主页)开始,读取网页的内容,在网页中找到其他链接地址,然后使用这些链接地址查找下一个网页。 ,因此循环将继续进行,直到此网站的所有网页都已被爬网。如果将Internet视为网站,则Spider可以使用此原理对Internet上的所有网页进行爬网。它在搜索引擎中占有重要地位,影响搜索引擎的检索和准确性,确定搜索引擎数据容量的大小,网络爬虫的质量直接影响搜索结果页面中的无效链接(即链接到搜索结果页面)。页数不存在。

1. 3 Web爬网程序在搜索引擎中的位置从上面搜索引擎的基本原理可以看出,Web爬网程序是一种可以跟踪Web上超链接结构并不断发现的网络爬虫。网络资源和采集程序。作为搜索引擎资源的一部分采集,网络采集器的性能将直接影响整个搜索引擎索引的网页的数量,质量和更新周期。 2基于主题采集器的个性化搜索引擎技术2. 1信息采集模型主题采集器基于普通的采集器,并通过在网页的整个处理过程中添加模块来实现个性化信息提取。这些模块包括主题确定模块,优化初始种子模块,主题相关性分析模块和排名模块。 (请参见图1)在图1中,有1个采集器模块检索了该网页。 2调用相关性分析模块以分析网页的相关性。 3爬行模块根据不同的分析结果进行相应的处理。 4爬网模块从数据库中获取等待处理的URL以继续工作,并循环到第一步,直到没有新的URL。 5排序网页的重要性。主题采集的关键是采集的结果与主题之间相似度的计算。可以通过相关的链接信息来预测结果为采集的相似度,以反映用户的个性化需求。 2. 2基于主题和用户个性化的爬网程序基于主题的爬网程序是选择性地搜索与预定义主题相关的页面的爬网程序。与基于整个Web的采集器相比,它不会采集与主题无关,节省硬件和网络资源的页面,并且由于数量很少而可以快速更新。

它还可以满足某些特定人群对特定领域信息的需求;基于用户个性化的采集器是一个轻量级的采集系统,其目标是引导用户的兴趣或与之互动。用户交互和其他方式来自采集信息,以向用户提供个性化服务。 2. 3超链接结构搜索策略基于链接结构的搜索策略的主要特征是使用Web结构信息来指导搜索,并通过分析Web页面之间的引用之间的关系来确定页面和链接的重要性。 。超链分析技术是主题搜索引擎使用的一种重要方法。下面将介绍几种重要的超链接分析算法。 2. 3. 1 PageRank算法PageRank算法是由斯坦福大学(Stanford University)(斯坦福大学)的Sergey Brin和Lawrence Page提出的。基本思想是:如果一个页面被许多其他页面引用,那么此页面很可能是重要页面;尽管该页面没有被多次引用,但是被一个重要页面引用了,那么该页面也可能是一个重要页面。重要页面;页面的重要性被平均划分并传递到它所引用的页面。页面重要性的量化分数是PageRank值。 Google的搜索引擎使用PageRank算法。网络中的超链接结构可以表示为有向图G =(V,E),其中V是节点(网页)的集合,E是边缘(当且仅当存在从第i页到第i页的链接时)在页面j中,在节点j)的边缘设置了一个从属节点i。假设页面u的链接网页为T1,T 2. .. Tn;参数d表示沿着该链接访问网页的“随机冲浪者”的衰减因子,取值范围为(0到1)之间,根据经验一般取值为0. 85。

C(Ti)表示从网页Ti链接到其他网页的链接数,PR(u)定义为网页u的链接权重。 PageRank值的计算公式为公式(1):其中e为1 / max,即max是所有网页的总和,分配给每个网页的初始权重是该总和的倒数。该算法的特征在于,指向网页的外部链接页面的页面级别越高,链接页面传递给网页的页面级别值就越高。因此,即使网页偶尔在内容中仅提及偏离查询主题的关键词语言,由于其较高的页面排名值,它也将获得相对较高的排名,这会影响搜索结果的相关性和相关性。精确。 2. 3. 2 HITS算法HITS算法由康奈尔大学的J. Kleinberg提出。 Kleinberg将网页分为两类,即集线器(中央级别)和权限(权限级别)。权威是具有较高价值的页面,并取决于指向它的页面,而集线器是指向更多权威并取决于它指向的页面的页面。 HITS算法的目标是通过某种计算方法(即具有最高排名的权威)来获取某个检索问题的最有价值的网页。但是,此算法在计算上比PageRank昂贵。而且它取决于用户的查询,实时性能很差。

此外,Authorities andhubs算法可能会出现“主题漂移”和“主题概括”现象。因此,“权威和中心”算法适用于各种主题的查询。 2. 3. 3 PageRank算法的改进。 PageRank算法的改进可以通过引入面向主题的思想并重新计算网页的链接关系来实现。首先,PageRank在发现页面重要性方面起着重要作用,但它并不针对某个特定主题(查询独立性)。这里,对PageRank方法进行了改进:在链接关系的基础上,增加了一定的语义信息权重,使得生成的重要页面针对某个主题,从而形成了SPageRank算法。 SPageRank算法不仅利用PageRank的优势来查找重要页面,而且还利用主题相关性。 2. 3. 4主题相关性算法搜索引擎的根源是传统的全文检索技术,并且搜索引擎遵循传统的信息检索模型。在用于计算文档相似度的传统算法中,Salton教授提出的向量空间模型是使用最广泛的算法。向量空间模型基于以下关键假设:组成文章的术语的出现顺序无关紧要,并且它们在文章主题中的作用彼此独立,因此可以将文档视为一系列无序条目的集合。

计算页面主题相关性的方法很多,例如NaiveBayes,神经网络,实例映射模型,向量空间模型(VSM)等。其中,向量空间模型对培训文档的要求较低。可以从少量的培训文档中提取出主要目标特征,计算简单,准确率高,更适合网络信息的发现。一种基于向量空间模型VSM的简单向量距离算法。该算法的基本思想是计算图2中两个向量之间的夹角的余弦值。VSM相似度的计算公式如公式(2):结论基于主题的个性化搜索引擎主要针对采集相关主题,并为用户提供个性化的信息服务。基于主题的采集的关键是计算采集的结果与主题之间的相似度。可以通过相关的链接信息来预测结果为采集的相似度,以反映用户的个性化需求。参考文献[1]高灵霞。基于主题爬虫的个性化搜索引擎技术分析[J]。计算机知识与技术.2009(32)[2]赵洪中李亚。垂直搜索引擎的应用研究[J]。现代商业工业。 2010(4)作者简介:陈晨(1989,5,11〜)女,汉族,哈尔滨大学工程学院,计算机科学与技术专业。基于主题爬虫的个性化搜索引擎技术研究陈晨(哈尔滨大学,哈尔滨15000,黑龙江0)摘要:基于主题爬虫的个性化搜索引擎技术借鉴了Web个性化推荐服务的思想,完善了Web表示搜索引擎的信息检索系统服务方法有效解决了互联网上“资源超载”和“信息丢失”的问题,相对满足了用户的需求。 关键词:主题采集器;搜索引擎;技术图1基于主题采集器的个性化信息采集模型图2 VSM模型图(2)

SEO理念指引:如何优化站内主题内容?(一)

网站优化 • 优采云 发表了文章 • 0 个评论 • 106 次浏览 • 2021-05-13 20:35

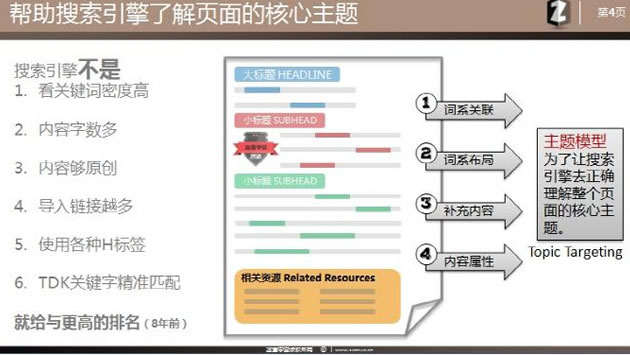

文章简介

SEO已进入全新纹理内容的算法系统,尤其是当今的一流搜索引擎可以处理内容场景和内容实体属性中的排名,从而使用户可以获得更准确的搜索结果。对于优化人员而言,网站优化不再是简单的内容填充,而是需要重新定义主题内容优化。本文将结合最新的SEO概念,以指导所有人如何优化主题内容。

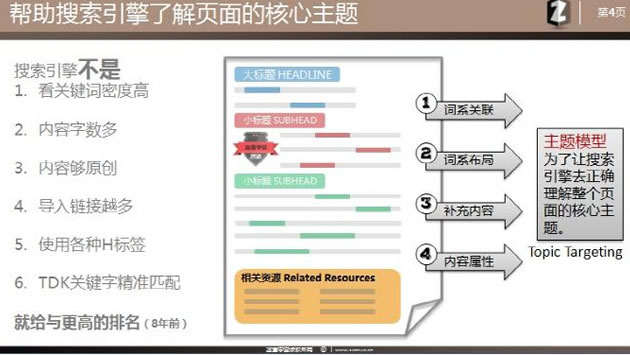

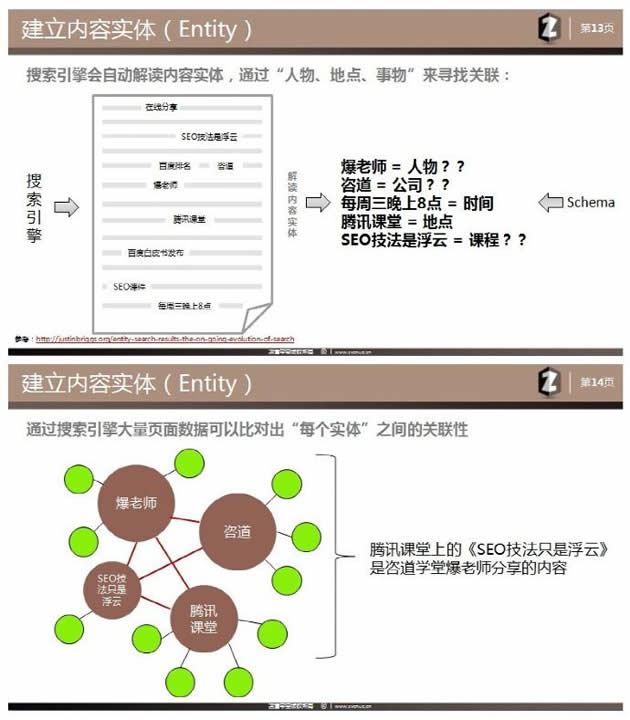

1. SEO网站的主题模型是什么

通常,我们可以听到并看到许多有关SEO页面内容的旧方法,例如:

看看关键词的密度是否符合标准

文章的内容是否有足够的单词?

内容是否足够原创

是否有足够的导入链接(外部链接)?

使用各种H标签集成关键词

TDK 关键词是否设置为完全匹配

但是经验丰富的SEO人士和网站所有者很快就会发现,这些技术似乎无法打动搜索引擎。是的,这些是8-9年前的技术。为了优化网站的内容,我们必须做的是如何使搜索引擎了解页面的核心主题。这是我今天的文章的核心。那么什么是主题模型?

主题模型是页面内容布局的模型,目的是允许搜索引擎正确理解整个页面的核心主题是什么,而不是传达许多关键词主题。因为一个页面可以收录很多信息,所以有些有用,有些则被采用,因此您只能通过将实际的核心信息传递给搜索引擎来获得相应的排名。因此,在主题模型中,我们需要实现一种全新的4步优化方法:

1)词法关联

2)词汇布局

3)补充内容

4)内容属性

对于Wikipedia等熟悉的网站,亚马逊使用其中的积分来获得大量的关键词排名。他们之所以部署在页面布局上,是因为它们的主干足够强大,可以有效地向搜索引擎大量展示核心内容主题。因此,在植入内容之后,可以创建大量最新页面。因此,无论您是白人还是老兵,即使您不了解搜索引擎算法,只要使用主题模型,就能获得不错的排名! (尤其是对于Google)

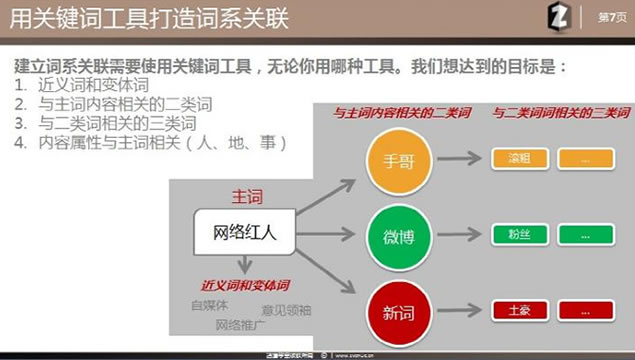

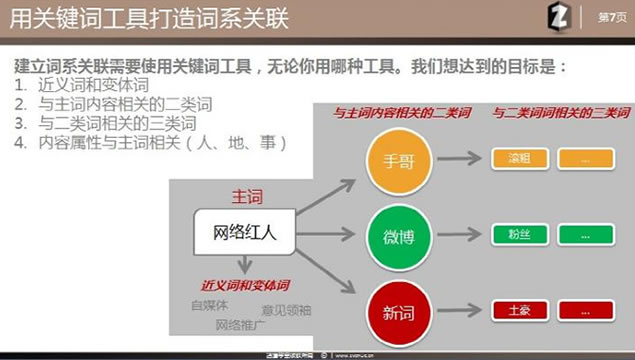

第一步:单词家族协会

无论您使用哪种方法来优化页面内容,都必须专注于如何关联单词和短语。作为内容编辑器,您撰写的内容最直接影响搜索引擎对页面主题的理解。

当我们使用句子和单词时,搜索引擎将根据其他资源中的数据将您的内容相关联,以生成所谓的内容实体。我们的优化人员首先需要研究关键词,以找出这些句子和单词之间的关系。我相信每个人都有自己的研究方法关键词,但是您需要实现以下目标:

1)查找同义词和变体

2)查找与主要单词的内容相关的第二类单词

3)找到与第二类单词相关的三种单词

4)得出结论,内容属性与主题(人,地点,物质)有关

让我举个例子。例如,如果您要优化称为[Internet名人]的关键词,则该词将成为您的主要词。根据目的(1),其同义词和变体词可以是自媒体意见领袖网络推广等;根据目的(2),与主题内容相关的第二种类型的词可以少留一些微博新单词;然后根据目的(3)查找与第二种单词相关的三种类型的单词,可以留下几手=粗略,否定分数,微博=粉丝,转发,新单词=土豪,问题又来了。

您可以清楚地看到单词和短语的每一层之间的某些关联。根据[4),我们尝试在这些内容与内容中的主词之间创建关联,尤其是在存在人,地点和事物的情况下。这可以帮助搜索引擎建立此类内容实体,因为还会有在其他网站上的此类关联(例如,在谈论Shouge时,他将提及他的微博,他的新评论,他的属性等),然后搜索引擎将正确地理解您的页面主题。通过主题,而不是关键词密度!

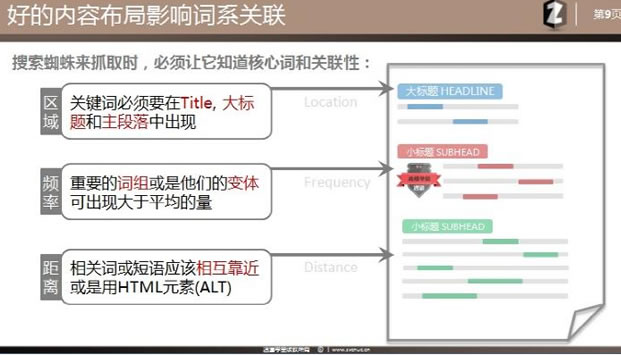

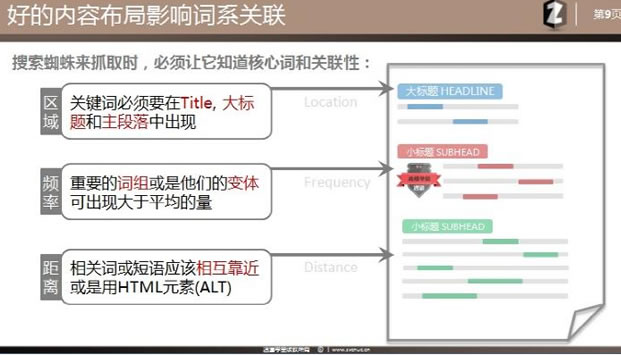

第2步:词法布局

毫无疑问,页面的布局对于搜索引擎理解内容主题也非常重要。蜘蛛程序到达页面并找到许多关键词后,有必要区分关键词和相关短语之间哪个重要,哪个重要。因此,词系统的布局是要区分核心词及其相关性。这是3种实用的优化方法:

1)区域:关键词必须出现在标题,标题和主要段落中

2)频率:重要短语或它们的变体出现的次数可能超过平均水平

3)距离:相关的词或短语应彼此靠近或使用HTML元素(例如ALT)

方法(1)是大多数SEO人员的必修项目,我们仍然需要将核心主题词放在标题,标题中,并尽可能多地出现在正文顶部。

方法(2)在这里不仅指关键词的频率(密度),而且指的是更复杂的链接频率水平,即核心单词的同义词和变体。在相同条件下,流行度较低同义词和变体词会得到更好的效果(Google拥有TF-IDF专利,这很难理解)

方法(3)距离产生美感不适用于SEO世界。单词,词组或句子应尽可能靠近放置,或者应使用HTML元素(例如图片ALT设置)。为了改善语言的上下文相关性,应通过段落,列表和分区使内容更明显。您可以一目了然地看到该段落所说的内容。句子前后是否有连通性,请不要分开内容具有相近的含义,因为您无法确保抓取工具会捕获全文。

您知道该方法的原理。现在,您要做的是将第二类单词和第三类单词分为不同的区域或段落或短语。目的是支持您的主要单词(排名单词)。前面提到的搜索引擎可以使用大数据来区分单词关联。举个简单的例子:

主要词是[Internet名人],第一段将重点放在这个词文章上。第二段使用几只手制作文章,第三段使用微博中继效果制作文章,第四段使用新的互联网名称制作文章。等等。您形成的Web内容是与单词家族相关的内容,单词家族通过第2步进行布局。

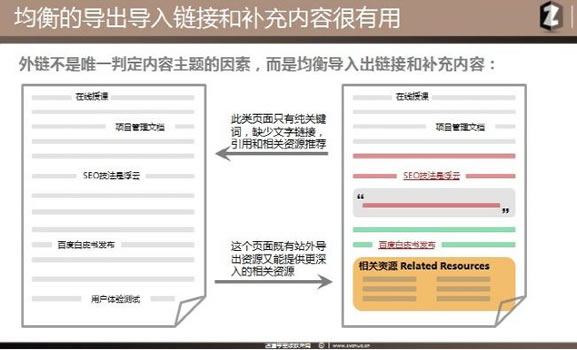

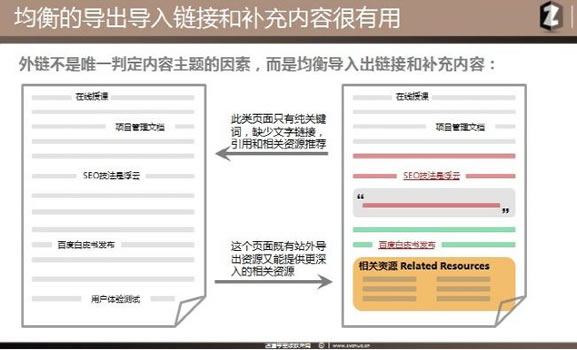

第3步:补充内容

也许很多人认为外部链接是告诉搜索引擎此页面主题的最有力信号。但是我们必须承认,今天的外部链接就像一颗不合时宜的炸弹,它们可能会被链接杀死。因此,搜索引擎希望每个人都可以同时使用内部链接和外部链接,向好的三方网站提出积极建议,并指导相关的网站内容。健康的网站应该进出,以便用户可以获得更多更好的信息,并且您的网站有意义。

因此,外部链接不是确定内容主题的唯一因素,而是平衡地导入链接和其他补充内容。那么补充内容是什么?从图表中可以看到,如果您的网页与左侧相同,则意味着该类型的网页仅是关键词,缺少文本链接,参考资料和相关资源推荐,因此您的网页非常僵化,是的。死角不会在页面上增加额外的分数。看一下右边的例子。此页面的内容中同时收录网站链接(黄色部分)和导出链接。例如,SEO技术是复云的课件,是老师的课件。这是给搜索引擎的消息。我有[补充]。想一想,百度百科还是知道为什么要添加指向相关资源的链接?实际上,它是通过不同站点的内容来增强页面主题的深化和增强信息。这是补充内容,可以为用户提供更好的信息,当然您的页面也将受到搜索引擎的奖励。

1)在页面底部添加到相关资源的链接(建议使用网站内链接);

2)在文本中使用引号,例如业内知名人士的文字或图标或视频;

3)使用文本中的导出链接转到第三方网站(K不会介意您100)。

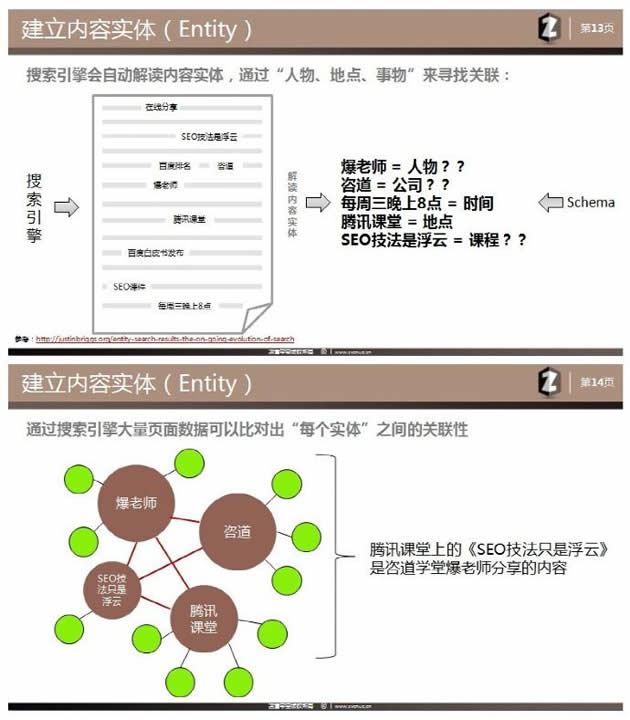

第4步:内容实体

这是一个非常困难的概念,英文为Entity。强大的搜索引擎将在爬网页面时自动解释内容实体,或将其理解为内容属性。例如,在图片的页面上,当内容提到爆炸性老师时,它的实体是[person]吗?当提到咨询时,是[公司]?因为当您的内容出现在互联网上的时间不够长时,数量就不会很长一段时间,搜索引擎可能无法解释内容实体,因为老师可以是姓氏的老师,也可以是动词老师的XX。目前,我们需要帮助搜索引擎正确解释内容实体。

通常,大多数搜索引擎为网站管理员提供其自己的结构化数据(百度也有这些数据)。什么是结构化数据?搜索引擎设置的HTML标记用于定义内容,或统称为使用Schema。以这种方式,当内容与公司有关时可以使用结构化数据,而在参考得分时可以使用另一种结构化数据。统计数据表明,全世界只有0. 3%网站使用Schema,所以要知道,这太高级了,我们只需要稍微了解一下即可。有机会让您的架构师整合网站结构化数据。

当然,提到的实体仍然是近年来出现的一个概念。过去,每个人都用单词来定义SEO,但现在更多地是针对实体。由于单词排名使用了过多的外部链主导的基于链的方法,因此结果排名始终使用户不满意,尤其是使用百度的用户认为搜索准确性比Google差了几步。

建立内容实体可以解决此问题,因为搜索引擎存储的大量页面数据可以比较每个实体之间的相关性。

摘要

每个人都可以使用此主题优化方法。高质量的页面就像是高等教育证书,其中记录了您的实体和相关性。最后,将以下优化技术集成到您的内容优化中:

1)描述页面主题的高度概括的标题

2)添加了用于描述页面内容的开场白(简短说明)

3)将内容分为几段,每段都有自己的主题

4)尝试尽可能扩大话题角度,并可以添加相关答案

5)提供其他现场或非现场辅助资源

6)不在乎单词的粗细,而是构建内容实体 查看全部

SEO理念指引:如何优化站内主题内容?(一)

文章简介

SEO已进入全新纹理内容的算法系统,尤其是当今的一流搜索引擎可以处理内容场景和内容实体属性中的排名,从而使用户可以获得更准确的搜索结果。对于优化人员而言,网站优化不再是简单的内容填充,而是需要重新定义主题内容优化。本文将结合最新的SEO概念,以指导所有人如何优化主题内容。

1. SEO网站的主题模型是什么

通常,我们可以听到并看到许多有关SEO页面内容的旧方法,例如:

看看关键词的密度是否符合标准

文章的内容是否有足够的单词?

内容是否足够原创

是否有足够的导入链接(外部链接)?

使用各种H标签集成关键词

TDK 关键词是否设置为完全匹配

但是经验丰富的SEO人士和网站所有者很快就会发现,这些技术似乎无法打动搜索引擎。是的,这些是8-9年前的技术。为了优化网站的内容,我们必须做的是如何使搜索引擎了解页面的核心主题。这是我今天的文章的核心。那么什么是主题模型?

主题模型是页面内容布局的模型,目的是允许搜索引擎正确理解整个页面的核心主题是什么,而不是传达许多关键词主题。因为一个页面可以收录很多信息,所以有些有用,有些则被采用,因此您只能通过将实际的核心信息传递给搜索引擎来获得相应的排名。因此,在主题模型中,我们需要实现一种全新的4步优化方法:

1)词法关联

2)词汇布局

3)补充内容

4)内容属性

对于Wikipedia等熟悉的网站,亚马逊使用其中的积分来获得大量的关键词排名。他们之所以部署在页面布局上,是因为它们的主干足够强大,可以有效地向搜索引擎大量展示核心内容主题。因此,在植入内容之后,可以创建大量最新页面。因此,无论您是白人还是老兵,即使您不了解搜索引擎算法,只要使用主题模型,就能获得不错的排名! (尤其是对于Google)

第一步:单词家族协会

无论您使用哪种方法来优化页面内容,都必须专注于如何关联单词和短语。作为内容编辑器,您撰写的内容最直接影响搜索引擎对页面主题的理解。

当我们使用句子和单词时,搜索引擎将根据其他资源中的数据将您的内容相关联,以生成所谓的内容实体。我们的优化人员首先需要研究关键词,以找出这些句子和单词之间的关系。我相信每个人都有自己的研究方法关键词,但是您需要实现以下目标:

1)查找同义词和变体

2)查找与主要单词的内容相关的第二类单词

3)找到与第二类单词相关的三种单词

4)得出结论,内容属性与主题(人,地点,物质)有关

让我举个例子。例如,如果您要优化称为[Internet名人]的关键词,则该词将成为您的主要词。根据目的(1),其同义词和变体词可以是自媒体意见领袖网络推广等;根据目的(2),与主题内容相关的第二种类型的词可以少留一些微博新单词;然后根据目的(3)查找与第二种单词相关的三种类型的单词,可以留下几手=粗略,否定分数,微博=粉丝,转发,新单词=土豪,问题又来了。

您可以清楚地看到单词和短语的每一层之间的某些关联。根据[4),我们尝试在这些内容与内容中的主词之间创建关联,尤其是在存在人,地点和事物的情况下。这可以帮助搜索引擎建立此类内容实体,因为还会有在其他网站上的此类关联(例如,在谈论Shouge时,他将提及他的微博,他的新评论,他的属性等),然后搜索引擎将正确地理解您的页面主题。通过主题,而不是关键词密度!

第2步:词法布局

毫无疑问,页面的布局对于搜索引擎理解内容主题也非常重要。蜘蛛程序到达页面并找到许多关键词后,有必要区分关键词和相关短语之间哪个重要,哪个重要。因此,词系统的布局是要区分核心词及其相关性。这是3种实用的优化方法:

1)区域:关键词必须出现在标题,标题和主要段落中

2)频率:重要短语或它们的变体出现的次数可能超过平均水平

3)距离:相关的词或短语应彼此靠近或使用HTML元素(例如ALT)

方法(1)是大多数SEO人员的必修项目,我们仍然需要将核心主题词放在标题,标题中,并尽可能多地出现在正文顶部。

方法(2)在这里不仅指关键词的频率(密度),而且指的是更复杂的链接频率水平,即核心单词的同义词和变体。在相同条件下,流行度较低同义词和变体词会得到更好的效果(Google拥有TF-IDF专利,这很难理解)

方法(3)距离产生美感不适用于SEO世界。单词,词组或句子应尽可能靠近放置,或者应使用HTML元素(例如图片ALT设置)。为了改善语言的上下文相关性,应通过段落,列表和分区使内容更明显。您可以一目了然地看到该段落所说的内容。句子前后是否有连通性,请不要分开内容具有相近的含义,因为您无法确保抓取工具会捕获全文。

您知道该方法的原理。现在,您要做的是将第二类单词和第三类单词分为不同的区域或段落或短语。目的是支持您的主要单词(排名单词)。前面提到的搜索引擎可以使用大数据来区分单词关联。举个简单的例子:

主要词是[Internet名人],第一段将重点放在这个词文章上。第二段使用几只手制作文章,第三段使用微博中继效果制作文章,第四段使用新的互联网名称制作文章。等等。您形成的Web内容是与单词家族相关的内容,单词家族通过第2步进行布局。

第3步:补充内容

也许很多人认为外部链接是告诉搜索引擎此页面主题的最有力信号。但是我们必须承认,今天的外部链接就像一颗不合时宜的炸弹,它们可能会被链接杀死。因此,搜索引擎希望每个人都可以同时使用内部链接和外部链接,向好的三方网站提出积极建议,并指导相关的网站内容。健康的网站应该进出,以便用户可以获得更多更好的信息,并且您的网站有意义。

因此,外部链接不是确定内容主题的唯一因素,而是平衡地导入链接和其他补充内容。那么补充内容是什么?从图表中可以看到,如果您的网页与左侧相同,则意味着该类型的网页仅是关键词,缺少文本链接,参考资料和相关资源推荐,因此您的网页非常僵化,是的。死角不会在页面上增加额外的分数。看一下右边的例子。此页面的内容中同时收录网站链接(黄色部分)和导出链接。例如,SEO技术是复云的课件,是老师的课件。这是给搜索引擎的消息。我有[补充]。想一想,百度百科还是知道为什么要添加指向相关资源的链接?实际上,它是通过不同站点的内容来增强页面主题的深化和增强信息。这是补充内容,可以为用户提供更好的信息,当然您的页面也将受到搜索引擎的奖励。

1)在页面底部添加到相关资源的链接(建议使用网站内链接);

2)在文本中使用引号,例如业内知名人士的文字或图标或视频;

3)使用文本中的导出链接转到第三方网站(K不会介意您100)。

第4步:内容实体

这是一个非常困难的概念,英文为Entity。强大的搜索引擎将在爬网页面时自动解释内容实体,或将其理解为内容属性。例如,在图片的页面上,当内容提到爆炸性老师时,它的实体是[person]吗?当提到咨询时,是[公司]?因为当您的内容出现在互联网上的时间不够长时,数量就不会很长一段时间,搜索引擎可能无法解释内容实体,因为老师可以是姓氏的老师,也可以是动词老师的XX。目前,我们需要帮助搜索引擎正确解释内容实体。

通常,大多数搜索引擎为网站管理员提供其自己的结构化数据(百度也有这些数据)。什么是结构化数据?搜索引擎设置的HTML标记用于定义内容,或统称为使用Schema。以这种方式,当内容与公司有关时可以使用结构化数据,而在参考得分时可以使用另一种结构化数据。统计数据表明,全世界只有0. 3%网站使用Schema,所以要知道,这太高级了,我们只需要稍微了解一下即可。有机会让您的架构师整合网站结构化数据。

当然,提到的实体仍然是近年来出现的一个概念。过去,每个人都用单词来定义SEO,但现在更多地是针对实体。由于单词排名使用了过多的外部链主导的基于链的方法,因此结果排名始终使用户不满意,尤其是使用百度的用户认为搜索准确性比Google差了几步。

建立内容实体可以解决此问题,因为搜索引擎存储的大量页面数据可以比较每个实体之间的相关性。

摘要

每个人都可以使用此主题优化方法。高质量的页面就像是高等教育证书,其中记录了您的实体和相关性。最后,将以下优化技术集成到您的内容优化中:

1)描述页面主题的高度概括的标题

2)添加了用于描述页面内容的开场白(简短说明)

3)将内容分为几段,每段都有自己的主题

4)尝试尽可能扩大话题角度,并可以添加相关答案

5)提供其他现场或非现场辅助资源

6)不在乎单词的粗细,而是构建内容实体

HTMLHTML基本结构lang是什么意思,你知道吗?

网站优化 • 优采云 发表了文章 • 0 个评论 • 225 次浏览 • 2021-05-12 07:29

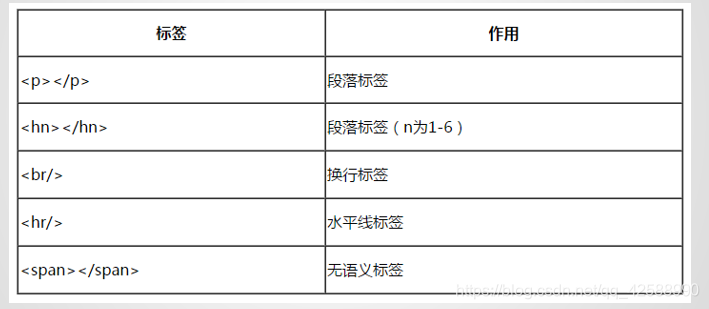

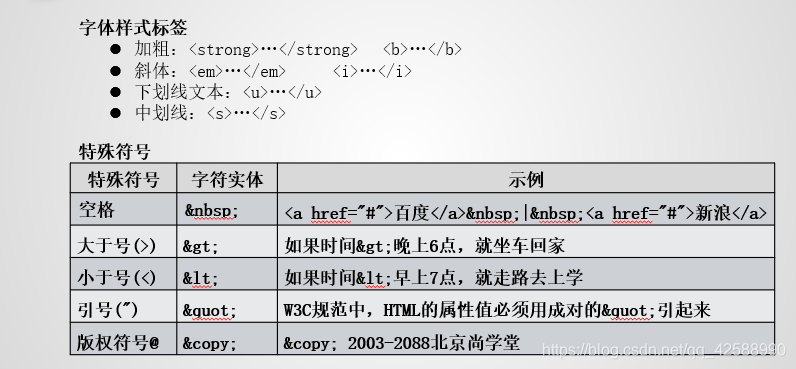

HTML

HTML基本结构

lang表示语言。 lang =“ en”属性在每个页面中声明主要语言。 En代表英语。这只是一个声明。宣布对搜索引擎和浏览器更友好。显示内容将被更改。它还具有zh-CN(代表中文)的通用值(搜索引擎不会确定网站是中文还是英文。它使搜索引擎知道您的网站是中文。这些都是HTML规范。更加标准化,更容易收录)

元标记用于描述HTML网页文档的属性。这里的charset =“ utf-8”表示当前使用的是utf-8编码格式。 GBK基于国家标准GB2312,并与GB2312兼容。专用于解决中文编码的GBK编码标准是双字节,而UTF-8编码是用于解决国际字符的多字节编码。

什么是DTD文档模型?为什么要用HTML编写?

DTD文档模型也称为DOCTYPE文档声明。它是Document TypeDefinition的英文缩写,表示文档类型定义。在HTML文档中,它用于指定页面使用的HTML(或XHTML)版本。要创建符合标准的页面,必不可少的关键组件是DOCTYPE声明。只有确定了正确的DOCTYPE后,HTML中的徽标和CSS才能正常生效。通常在页面的第一行html标记之前定义。

它不是HTML标记。

我们已经编写了一个HTML文档。目前,这都是代码,用户无法理解。我们是否必须使用浏览器中的引擎进行翻译?用户可以看到界面。关键是HTML有很多版本,浏览器如何知道要解释哪个版本?爸爸要你打扫地板,妈妈要你洗碗。长辈都是你听的人。目前,如果您制定了家庭规定,并且一切都由您父亲决定,那么这是一个非常简单的解决方案。 ,要扫地。这个DTD文件模型就是这个意思。不管它有多少个HTML版本,我都将指定我编写的HTML文档为准,然后我将知道最终页面将被解释为什么。

DTD文档模型= DOCTYPE = DOCTYPE文档声明

用于定义文档的标题。它是所有头部元素的容器。头部的元素可以引用脚本,并指示浏览器在哪里找到样式表。文档的标题描述了文档的各种属性和信息,包括文档的标题,其在网络上的位置以及与其他文档的关系。文档标题中收录的大多数数据都不会作为内容显示给读者。

以下标签可以在头部使用:

、、、、

标签应放置在文档的开头,紧接在标签之后和之前。文档的头部通常收录一些标签,以告知浏览器有关该文档的其他信息。

1、可以定义文档的标题

2、显示在浏览器窗口的标题栏或状态栏上

3、将文档添加到用户的采集夹或书签列表时,标题将成为该文档的默认名称

4、标题标签是必须收录在head标签中的唯一内容,也就是说,编写head时必须具有标题。这并不意味着您没有添加其他内容,而是必须添加标题。

5、 title撰写与您的网页相关的关键词有助于SEO优化。

SEO是搜索引擎优化的英文缩写

通过调整网站的内容以满足搜索引擎的排名需求,从而增加网站被搜索引擎平台接受的机会,从而将准确的用户吸引到网站。 网站有一个目标群体。通过标题和元标记,目标组可以找到您的网站至关键词,因此您定义的关键词决定了您将吸引哪种类型的组。

The

element可以提供有关页面的元信息,用于向浏览器或搜索引擎描述页面。例如,文档的描述和关键词。它只能放在头部。属于元信息标签。

通用元具有

关键字用于告诉搜索引擎您网页的关键字是什么。

描述(网站内容描述)描述用于告诉搜索引擎您的网站主要内容。

作者作者标记网页的作者

语义标签

语义化:了解每个标签的用途(在什么情况下合理使用此标签)例如:网页上的文章标题可以使用标题标签h1-h6,段落使用p,地址使用地址等

好处:

1、更易于由搜索引擎收录进行搜索

2、屏幕阅读器可以更轻松地读取网页。

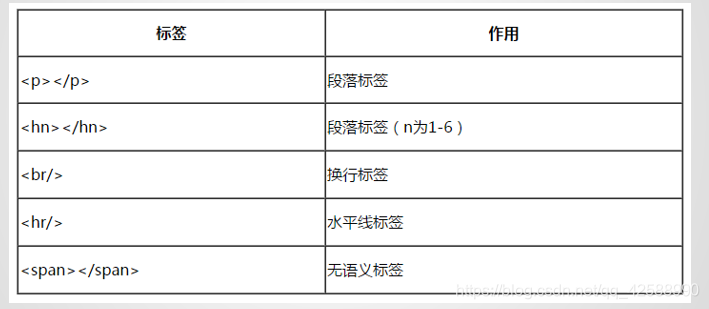

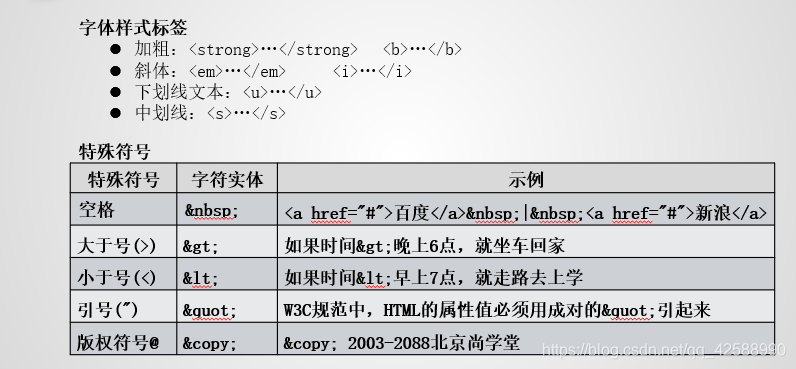

HTML中常用的标签

图片

1、使用

在页面上添加图片

2、空标记

3、必填属性:src(图像存储位置)

4、常用属性:宽度,高度,高度,标题

<p> 查看全部

HTMLHTML基本结构lang是什么意思,你知道吗?

HTML

HTML基本结构

lang表示语言。 lang =“ en”属性在每个页面中声明主要语言。 En代表英语。这只是一个声明。宣布对搜索引擎和浏览器更友好。显示内容将被更改。它还具有zh-CN(代表中文)的通用值(搜索引擎不会确定网站是中文还是英文。它使搜索引擎知道您的网站是中文。这些都是HTML规范。更加标准化,更容易收录)

元标记用于描述HTML网页文档的属性。这里的charset =“ utf-8”表示当前使用的是utf-8编码格式。 GBK基于国家标准GB2312,并与GB2312兼容。专用于解决中文编码的GBK编码标准是双字节,而UTF-8编码是用于解决国际字符的多字节编码。

什么是DTD文档模型?为什么要用HTML编写?

DTD文档模型也称为DOCTYPE文档声明。它是Document TypeDefinition的英文缩写,表示文档类型定义。在HTML文档中,它用于指定页面使用的HTML(或XHTML)版本。要创建符合标准的页面,必不可少的关键组件是DOCTYPE声明。只有确定了正确的DOCTYPE后,HTML中的徽标和CSS才能正常生效。通常在页面的第一行html标记之前定义。

它不是HTML标记。

我们已经编写了一个HTML文档。目前,这都是代码,用户无法理解。我们是否必须使用浏览器中的引擎进行翻译?用户可以看到界面。关键是HTML有很多版本,浏览器如何知道要解释哪个版本?爸爸要你打扫地板,妈妈要你洗碗。长辈都是你听的人。目前,如果您制定了家庭规定,并且一切都由您父亲决定,那么这是一个非常简单的解决方案。 ,要扫地。这个DTD文件模型就是这个意思。不管它有多少个HTML版本,我都将指定我编写的HTML文档为准,然后我将知道最终页面将被解释为什么。

DTD文档模型= DOCTYPE = DOCTYPE文档声明

用于定义文档的标题。它是所有头部元素的容器。头部的元素可以引用脚本,并指示浏览器在哪里找到样式表。文档的标题描述了文档的各种属性和信息,包括文档的标题,其在网络上的位置以及与其他文档的关系。文档标题中收录的大多数数据都不会作为内容显示给读者。

以下标签可以在头部使用:

、、、、

标签应放置在文档的开头,紧接在标签之后和之前。文档的头部通常收录一些标签,以告知浏览器有关该文档的其他信息。

1、可以定义文档的标题

2、显示在浏览器窗口的标题栏或状态栏上

3、将文档添加到用户的采集夹或书签列表时,标题将成为该文档的默认名称

4、标题标签是必须收录在head标签中的唯一内容,也就是说,编写head时必须具有标题。这并不意味着您没有添加其他内容,而是必须添加标题。

5、 title撰写与您的网页相关的关键词有助于SEO优化。

SEO是搜索引擎优化的英文缩写

通过调整网站的内容以满足搜索引擎的排名需求,从而增加网站被搜索引擎平台接受的机会,从而将准确的用户吸引到网站。 网站有一个目标群体。通过标题和元标记,目标组可以找到您的网站至关键词,因此您定义的关键词决定了您将吸引哪种类型的组。

The

element可以提供有关页面的元信息,用于向浏览器或搜索引擎描述页面。例如,文档的描述和关键词。它只能放在头部。属于元信息标签。

通用元具有

关键字用于告诉搜索引擎您网页的关键字是什么。

描述(网站内容描述)描述用于告诉搜索引擎您的网站主要内容。

作者作者标记网页的作者

语义标签

语义化:了解每个标签的用途(在什么情况下合理使用此标签)例如:网页上的文章标题可以使用标题标签h1-h6,段落使用p,地址使用地址等

好处:

1、更易于由搜索引擎收录进行搜索

2、屏幕阅读器可以更轻松地读取网页。

HTML中常用的标签

图片

1、使用

在页面上添加图片

2、空标记

3、必填属性:src(图像存储位置)

4、常用属性:宽度,高度,高度,标题

<p>

成功的SEO金字塔模型图"简单概括性的介绍了

网站优化 • 优采云 发表了文章 • 0 个评论 • 131 次浏览 • 2021-05-12 07:26

成功的SEO金字塔模型图"简单概括性的介绍了

SEO的详细信息:成功的SEO金字塔模型

在普通人眼中,SEO只是一种使用某些技能和方法来实现排名目标的技能。实际上,做好网站 SEO实质上是一个系统过程,并且在操作过程中渗透了各种细节。垃圾站方面旨在满足搜索引擎的处理算法。由于算法的不一致,完善会导致垃圾邮件的可能性。随着搜索引擎的不断更新,垃圾邮件站点变得越来越疲惫和痛苦,并且无论搜索算法如何变化,真正优秀的SEO站点仍将排名。并没有太大变化。

下面的“成功的SEO金字塔模型图”简要介绍了SEO的详细信息。

团队执行能力

如上所述,SEO是一个系统的项目,因此它需要一个良好的分工,这需要一个好的团队。如果仅仅是一个人的团队,那就需要很多辛苦的工作!

项目计划

整个项目的计划和监督非常重要。对于单个网站管理员来说,如何评估项目的性能还不够或不容易忽视。

产品和服务

无论是销售产品还是提供服务,您都需要了解您的用户,了解您的产品,然后了解用户的想法,以便实现SEO

获得信息的能力

对于SEOer来说,这是一项必不可少的技能,而不是让您拥有百度。您只是盲目地知道自己是信息大师!

耐心和毅力

每个人都希望快速成功,但这并不容易。原创狩猎时代已经过去,现在我们已经进入了囚禁时代。您必须有耐心来提高猎物以获取更多。用户体验

改善了用户体验,所有问题都解决了一半,升级也更加容易。即使搜索引擎在当天死亡,您也不会因为他的高龄而成为葬礼!

关键词策略 查看全部

成功的SEO金字塔模型图"简单概括性的介绍了

SEO的详细信息:成功的SEO金字塔模型

在普通人眼中,SEO只是一种使用某些技能和方法来实现排名目标的技能。实际上,做好网站 SEO实质上是一个系统过程,并且在操作过程中渗透了各种细节。垃圾站方面旨在满足搜索引擎的处理算法。由于算法的不一致,完善会导致垃圾邮件的可能性。随着搜索引擎的不断更新,垃圾邮件站点变得越来越疲惫和痛苦,并且无论搜索算法如何变化,真正优秀的SEO站点仍将排名。并没有太大变化。

下面的“成功的SEO金字塔模型图”简要介绍了SEO的详细信息。

团队执行能力

如上所述,SEO是一个系统的项目,因此它需要一个良好的分工,这需要一个好的团队。如果仅仅是一个人的团队,那就需要很多辛苦的工作!

项目计划

整个项目的计划和监督非常重要。对于单个网站管理员来说,如何评估项目的性能还不够或不容易忽视。

产品和服务

无论是销售产品还是提供服务,您都需要了解您的用户,了解您的产品,然后了解用户的想法,以便实现SEO

获得信息的能力

对于SEOer来说,这是一项必不可少的技能,而不是让您拥有百度。您只是盲目地知道自己是信息大师!

耐心和毅力

每个人都希望快速成功,但这并不容易。原创狩猎时代已经过去,现在我们已经进入了囚禁时代。您必须有耐心来提高猎物以获取更多。用户体验

改善了用户体验,所有问题都解决了一半,升级也更加容易。即使搜索引擎在当天死亡,您也不会因为他的高龄而成为葬礼!

关键词策略

国内外搜索引擎的发展背景及影响的SEO技术分析

网站优化 • 优采云 发表了文章 • 0 个评论 • 118 次浏览 • 2021-05-11 04:03

网络的出现和快速发展引起了信息检索环境的重大变化。基于Internet的搜索引擎的排名算法直接关系到新环境中信息检索的用户体验。现有的搜索引擎排名算法主要基于Web链接结构。两种主要的代表性算法是PageRank算法和Hits算法。基于这两种算法,国内外许多学者和研究机构进行了新的探索。和改进。

在此基础上,已经形成了一些适合搜索引擎的成熟的综合排名模型。本文研究和分析了国内外搜索引擎的发展背景,以及对搜索引擎排名有重要影响的SEO技术。在此基础上,对PageRank算法和Hits算法进行了深入的分析。

一、 PageRank

算法PageRank是最著名的搜索引擎Google采用的算法策略。它基于每个网页的超链接信息来计算网页的权重,以优化搜索引擎的结果。拉里·佩奇(Larry Page)提出。

简单地说,PageRank算法计算每个网页的综合得分,也就是说,如果网页A链接到网页B,则网页B当然会加1分。不同的链接网页具有指向网页的不同点。页面的分数是通过递归算法获得链接到该页面的所有页面的重要性的。

PageRank算法的基本原理推导如下:

PR(A)=(1-d)+ d *(PR(T 1) / C(T 1) + ... + PR(Tn)/ C(Tn))

其中PR(A)是指A页的PR值。

T1,T2,...,Tn是指页面A的链接页面。

PR(Ti)表示页面Ti(i = 1,2,...,n)的PR值。

C(Ti)表示来自网页Ti(i = 1,2,...,n)的链接数。

D是衰减因子,0

从上式可以看出,影响网页PR值的主要因素如下:

([1)指向此页面的链接数。

(2)链接到网页本身的网页的PR值。

([3)指向网页本身的链接数。

根据以上分析,可以判断:链接的数量越多,则这些链接的页面的PR值越高,这些页面的链接数越少,则PR值越高。该网页的内容。

Google为每个网页分配一个初始PR值(1-d),然后使用PageRank算法收敛以计算其PR值。

网页的输入和输出关系一直在变化,因此PR值也需要更新。可以通过定时任务反复计算后进行更新,以使网页的最终PR值达到平衡且稳定的状态。

Google的查询过程如下:首先,根据用户输入的查询关键词匹配Web数据库中的网页,然后根据他们自己的PR排名向用户展示匹配的网页。

此外,网页在搜索结果列表中的位置还与许多其他因素相关,例如搜索词在网页中的位置。

PageRank的缺点是它不考虑链接的值。这更适合于常规搜索引擎,但是对于与主题相关的垂直搜索引擎来说,这不是一个好的策略。

二、 HITS

PageRank算法对出站链接权重的贡献是平均的,也就是说,没有考虑不同链接的重要性,但是某些页面链接可能是广告,导航或注释链接,而平均权重显然不是符合实际情况。

HITS(超链接诱导主题搜索)算法是一种经典的主题信息提取策略,可以提高垂直精度。

1、原理

HITS算法是乔恩·克莱因伯格(Jon Kleinberg)提出的,它为每个网页计算两个值:权威性和中心性。

([1)权威页面

一个网页被多次引用,这可能非常重要;尽管一个网页没有被多次引用,但是它被重要的网页引用,但它也可能非常重要;将网页的重要性平均化后传递到它所引用的网页。这样的页面称为权威页面。

([2) Hub网页

一个网页,提供指向权威网页的链接的集合。它本身可能并不重要,或者指向它的网页很少,但是它提供了指向某个主题上最重要站点的链接的集合。这种网页称为集线器网页。

([3)算法思想

首先,使用常规搜索引擎来获取网页的初始子集I。当然,I中的页面与用户的查询条件非常相关。然后包括由I指向的网页和指向I的网页以形成基本集E。E中的每个页面都有权限权重和集线器权重,分别表示为a和h。 a值表示网页和查询条件相关性级别,h表示页面链接到相关性页面的数量。 a =(a1,a2,...,an)和h =(h1,h2,...,hn)表示E中所有网页的权限和中心向量。最初将ai和hi都设置为1,并且然后使用以下公式进行计算:

其中,B(i)和F(i)分别表示指向该网页的网页链接的集合和指向该网页的网页链接的集合。使用n * n矩阵A表示集合E的网页节点之间的连接。如果节点i和节点j之间存在连接,则A [i,j] = 1,然后A [i,j] = 0,因此,上式可以表示为:

迭代计算a和h直至收敛。这样,我们专注于ATA和AAT。最后,按权限和中心值排序,然后选择a和h的值大于阈值M的网页。

如果许多良好的枢纽指向一个网页,则其权限值将相应增加;如果某个网页指向许多优质的权威页面,则中心值也会相应增加。 HITS算法的最终输出是一组具有较大中心值的网页和具有较大权限值的网页。

2、缺陷

虽然HITS算法提高了一定的垂直精度,但它也具有以下缺点:

(1) HITS算法忽略网页内容的差异,并为每个链接的网页分配相同的加权常数,因为每个网页都会有一些无关的链接网页,例如广告链接。这些无关的网页和相关的“处理网页”同样容易导致主体漂移。

(2)在url集合E的开头,还将初始集合I中的某些网页的无关链接添加到E中,这增加了不必要的下载量,并导致更多无关的网页参与了计算,对准确性有一定影响。

3、改进

改进方向如下:

([1)主题漂移

([2)下载过滤器

以上是搜索引擎技术的排序算法。尽管该公式有点麻烦,但如果仔细研究,您会有所收获。谢谢您的阅读。 查看全部

国内外搜索引擎的发展背景及影响的SEO技术分析

网络的出现和快速发展引起了信息检索环境的重大变化。基于Internet的搜索引擎的排名算法直接关系到新环境中信息检索的用户体验。现有的搜索引擎排名算法主要基于Web链接结构。两种主要的代表性算法是PageRank算法和Hits算法。基于这两种算法,国内外许多学者和研究机构进行了新的探索。和改进。

在此基础上,已经形成了一些适合搜索引擎的成熟的综合排名模型。本文研究和分析了国内外搜索引擎的发展背景,以及对搜索引擎排名有重要影响的SEO技术。在此基础上,对PageRank算法和Hits算法进行了深入的分析。

一、 PageRank

算法PageRank是最著名的搜索引擎Google采用的算法策略。它基于每个网页的超链接信息来计算网页的权重,以优化搜索引擎的结果。拉里·佩奇(Larry Page)提出。

简单地说,PageRank算法计算每个网页的综合得分,也就是说,如果网页A链接到网页B,则网页B当然会加1分。不同的链接网页具有指向网页的不同点。页面的分数是通过递归算法获得链接到该页面的所有页面的重要性的。

PageRank算法的基本原理推导如下:

PR(A)=(1-d)+ d *(PR(T 1) / C(T 1) + ... + PR(Tn)/ C(Tn))

其中PR(A)是指A页的PR值。

T1,T2,...,Tn是指页面A的链接页面。

PR(Ti)表示页面Ti(i = 1,2,...,n)的PR值。

C(Ti)表示来自网页Ti(i = 1,2,...,n)的链接数。

D是衰减因子,0

从上式可以看出,影响网页PR值的主要因素如下:

([1)指向此页面的链接数。

(2)链接到网页本身的网页的PR值。

([3)指向网页本身的链接数。

根据以上分析,可以判断:链接的数量越多,则这些链接的页面的PR值越高,这些页面的链接数越少,则PR值越高。该网页的内容。

Google为每个网页分配一个初始PR值(1-d),然后使用PageRank算法收敛以计算其PR值。

网页的输入和输出关系一直在变化,因此PR值也需要更新。可以通过定时任务反复计算后进行更新,以使网页的最终PR值达到平衡且稳定的状态。

Google的查询过程如下:首先,根据用户输入的查询关键词匹配Web数据库中的网页,然后根据他们自己的PR排名向用户展示匹配的网页。

此外,网页在搜索结果列表中的位置还与许多其他因素相关,例如搜索词在网页中的位置。

PageRank的缺点是它不考虑链接的值。这更适合于常规搜索引擎,但是对于与主题相关的垂直搜索引擎来说,这不是一个好的策略。

二、 HITS

PageRank算法对出站链接权重的贡献是平均的,也就是说,没有考虑不同链接的重要性,但是某些页面链接可能是广告,导航或注释链接,而平均权重显然不是符合实际情况。

HITS(超链接诱导主题搜索)算法是一种经典的主题信息提取策略,可以提高垂直精度。

1、原理

HITS算法是乔恩·克莱因伯格(Jon Kleinberg)提出的,它为每个网页计算两个值:权威性和中心性。

([1)权威页面

一个网页被多次引用,这可能非常重要;尽管一个网页没有被多次引用,但是它被重要的网页引用,但它也可能非常重要;将网页的重要性平均化后传递到它所引用的网页。这样的页面称为权威页面。

([2) Hub网页

一个网页,提供指向权威网页的链接的集合。它本身可能并不重要,或者指向它的网页很少,但是它提供了指向某个主题上最重要站点的链接的集合。这种网页称为集线器网页。

([3)算法思想

首先,使用常规搜索引擎来获取网页的初始子集I。当然,I中的页面与用户的查询条件非常相关。然后包括由I指向的网页和指向I的网页以形成基本集E。E中的每个页面都有权限权重和集线器权重,分别表示为a和h。 a值表示网页和查询条件相关性级别,h表示页面链接到相关性页面的数量。 a =(a1,a2,...,an)和h =(h1,h2,...,hn)表示E中所有网页的权限和中心向量。最初将ai和hi都设置为1,并且然后使用以下公式进行计算:

其中,B(i)和F(i)分别表示指向该网页的网页链接的集合和指向该网页的网页链接的集合。使用n * n矩阵A表示集合E的网页节点之间的连接。如果节点i和节点j之间存在连接,则A [i,j] = 1,然后A [i,j] = 0,因此,上式可以表示为:

迭代计算a和h直至收敛。这样,我们专注于ATA和AAT。最后,按权限和中心值排序,然后选择a和h的值大于阈值M的网页。

如果许多良好的枢纽指向一个网页,则其权限值将相应增加;如果某个网页指向许多优质的权威页面,则中心值也会相应增加。 HITS算法的最终输出是一组具有较大中心值的网页和具有较大权限值的网页。

2、缺陷

虽然HITS算法提高了一定的垂直精度,但它也具有以下缺点:

(1) HITS算法忽略网页内容的差异,并为每个链接的网页分配相同的加权常数,因为每个网页都会有一些无关的链接网页,例如广告链接。这些无关的网页和相关的“处理网页”同样容易导致主体漂移。

(2)在url集合E的开头,还将初始集合I中的某些网页的无关链接添加到E中,这增加了不必要的下载量,并导致更多无关的网页参与了计算,对准确性有一定影响。

3、改进

改进方向如下:

([1)主题漂移

([2)下载过滤器

以上是搜索引擎技术的排序算法。尽管该公式有点麻烦,但如果仔细研究,您会有所收获。谢谢您的阅读。

集搜客:搜索引擎主题模型优化(cnn)使用技巧

网站优化 • 优采云 发表了文章 • 0 个评论 • 127 次浏览 • 2021-05-10 01:03

搜索引擎主题模型优化(cnn)可以了解一下我们建立的一个关于cnn的主题模型:集搜客:cnn使用技巧介绍,在搜索引擎主题模型优化的工程应用我们提供cnn主题模型优化工程仿真平台,不需要编写程序,

传统的搜索引擎文本的主题通常有这样的结构:根据“每一篇文章中的xx人xx事件xx有xx意义”来区分关键词/文章if(这个标记可以用无向图表示)或者如果文本本身非常可能覆盖所有文章,那么还可以采用二分词的方式(假设所有文章都是分词的)。当然还有其他的方式,参见:基于二分图的embedding。综上,搜索的文本主题通常可以有这样的结构:例如“元老级人物+利国利民”是十分有价值的。

然而,虽然关键词非常有价值,同时为了保持有价值的主题,搜索引擎文本通常都不会是关键词本身,而是关键词附近的区域。例如,如果只取“03年非典”来做主题,或者只取“张兴海”来做主题,那么文本的主题空间就很小。所以,如果搜索引擎文本中的主题是小规模的,或者说对用户来说可能不完全是关键词或文章之间的交集(例如“地理位置”是一个区域,“mx4”是一个文件夹的关系),那么具有一定的关联性更有意义。

如果搜索引擎文本的主题是非常大规模的,而且有很明显的分类,例如“世界多大”、“国家”这样的大分类,那么具有关联性更有意义。这时也有相应的主题模型或主题树模型,例如bert:llmtreenoderepresentationlearningforlarge-scalenaturallanguageprocessing。 查看全部

集搜客:搜索引擎主题模型优化(cnn)使用技巧

搜索引擎主题模型优化(cnn)可以了解一下我们建立的一个关于cnn的主题模型:集搜客:cnn使用技巧介绍,在搜索引擎主题模型优化的工程应用我们提供cnn主题模型优化工程仿真平台,不需要编写程序,

传统的搜索引擎文本的主题通常有这样的结构:根据“每一篇文章中的xx人xx事件xx有xx意义”来区分关键词/文章if(这个标记可以用无向图表示)或者如果文本本身非常可能覆盖所有文章,那么还可以采用二分词的方式(假设所有文章都是分词的)。当然还有其他的方式,参见:基于二分图的embedding。综上,搜索的文本主题通常可以有这样的结构:例如“元老级人物+利国利民”是十分有价值的。

然而,虽然关键词非常有价值,同时为了保持有价值的主题,搜索引擎文本通常都不会是关键词本身,而是关键词附近的区域。例如,如果只取“03年非典”来做主题,或者只取“张兴海”来做主题,那么文本的主题空间就很小。所以,如果搜索引擎文本中的主题是小规模的,或者说对用户来说可能不完全是关键词或文章之间的交集(例如“地理位置”是一个区域,“mx4”是一个文件夹的关系),那么具有一定的关联性更有意义。

如果搜索引擎文本的主题是非常大规模的,而且有很明显的分类,例如“世界多大”、“国家”这样的大分类,那么具有关联性更有意义。这时也有相应的主题模型或主题树模型,例如bert:llmtreenoderepresentationlearningforlarge-scalenaturallanguageprocessing。

中小微企业很难活,自己也感觉太疲累了

网站优化 • 优采云 发表了文章 • 0 个评论 • 139 次浏览 • 2021-05-06 05:10

在过去十年左右的时间里,除了做一些技术外,我还主要关注运营和数字营销。自2008年我开始学习Google seo至今已有12年了。回想起来,我感到非常激动。有些以前服务过的公司不复存在,有些已经被后来的公司超越。企业家的变化太多了。中小企业很难生存,我感到太累了。多年来,我已经对seo的核心思想进行了规划,并与该行业的从业者分享了它,以免出错。

一、 网站内容优化

搜索引擎必须向用户显示高质量的内容,实现搜索价值和用户价值,并使搜索引擎服务提供商和用户获得多重胜利,从而为持续生存提供营养。过去,我们经常说内容为王,一切目的都是为了创造高质量的内容。作为一般网民,长时间网站的内容更新很困难,因为您需要创建许多新的高质量内容。这种创建并不像复制和粘贴那样简单。这就像写一篇文章,使您每天都可以撰写不同主题的文章。对于大多数人来说,这应该是不可持续的。

创建内容的最佳方法是选择与主题相关的网站。仅当您继续围绕该方向进行创建时,您才会显得专业且专注,并且搜索引擎会更容易推荐它。 seo领域的很多人都听说过zac,他的博客内容基本上是围绕seo主题发布的文章,因此直到现在,即使更新不多,搜索引擎中的权重仍然很高。

除了原创的高质量内容外,网站的内容也需要经常更新,以便它可以吸引来自搜索引擎的爬行蜘蛛频繁进入并进入索引库。当用户搜索时,可以将其显示给用户。

二、 关键词优化

seo 关键词优化。从两部分开始,第一部分是网站的内容中的关键词。通常关键词的密度为2%-8%。可以使用这种检测方法。网站管理员工具进行检测。 文章的开头和结尾应该有关键词,就像电影的开头和结尾一样,开头和结尾都是照应的。第二部分是技术标签上的关键词。所有网站都应带有一个meta标签。该标签收录:关键字和描述。通过网页源代码工具,您可以看到此标记的表示形式:SEO,搜索引擎优化“ />,搜索引擎优化” />,其中的内容是特定的关键词和说明。这主要是让搜索引擎蜘蛛看到的,以便蜘蛛可以识别网站的内容。

三、链接优化

整个互联网可以说是由数千个链接组成的。 网站链接的优化是允许用户和搜索引擎以最简单的方式找到该网站。这里也有两个方面。第一个方面是网站本身的链接。搜索引擎在早期很难或不友好地识别动态URL。动态URL(例如:,问号是动态符号)比该结构是否是后者更容易理解。但是,随着人工智能等高科技的发展,搜索引擎现在能够识别动态URL,但它们仍然不友好。世界上所有知名的网站基本上都是静态URL。这里提到的静态URL是动态网站的伪静态,而实际的静态URL通常是直接的html文件。

链接优化的另一个方面是外部链接的构建。外部链接可以通过点击其他人的网站来访问我们的网站。外部链接的构建非常困难。如果您在某个方面是名人,那可能会更好。 ,没有人想在他的网站上推荐一个陌生人网站。如果网站的权重较高,则推荐您的网站,那么您的网站的权重也会更高,流量也会更大。实际上,任何搜索引擎都尚未正式认可此权重声明。网站站长工具会根据经验进行观察。例如,爱站具有百度权重值,并且它们根据网站的综合属性分配一定的值。最高值为9。在外部链接的过程中,我们至少需要权重值为5或更大的网站来推荐您,以便您的访问量能够增加。

以上三个方面是搜索引擎优化的核心。本文将不对具体细节进行过多解释。作为SEO从业人员或想进入这个行业的人,他们应该专注于这些方面。此外,该网站还收录Google和百度与SEO相关的知识和技能。您可以使用该网站的搜索功能进行搜索,也可以通过我的微信,微博和电子邮件进行交流。 查看全部

中小微企业很难活,自己也感觉太疲累了

在过去十年左右的时间里,除了做一些技术外,我还主要关注运营和数字营销。自2008年我开始学习Google seo至今已有12年了。回想起来,我感到非常激动。有些以前服务过的公司不复存在,有些已经被后来的公司超越。企业家的变化太多了。中小企业很难生存,我感到太累了。多年来,我已经对seo的核心思想进行了规划,并与该行业的从业者分享了它,以免出错。

一、 网站内容优化

搜索引擎必须向用户显示高质量的内容,实现搜索价值和用户价值,并使搜索引擎服务提供商和用户获得多重胜利,从而为持续生存提供营养。过去,我们经常说内容为王,一切目的都是为了创造高质量的内容。作为一般网民,长时间网站的内容更新很困难,因为您需要创建许多新的高质量内容。这种创建并不像复制和粘贴那样简单。这就像写一篇文章,使您每天都可以撰写不同主题的文章。对于大多数人来说,这应该是不可持续的。

创建内容的最佳方法是选择与主题相关的网站。仅当您继续围绕该方向进行创建时,您才会显得专业且专注,并且搜索引擎会更容易推荐它。 seo领域的很多人都听说过zac,他的博客内容基本上是围绕seo主题发布的文章,因此直到现在,即使更新不多,搜索引擎中的权重仍然很高。

除了原创的高质量内容外,网站的内容也需要经常更新,以便它可以吸引来自搜索引擎的爬行蜘蛛频繁进入并进入索引库。当用户搜索时,可以将其显示给用户。

二、 关键词优化

seo 关键词优化。从两部分开始,第一部分是网站的内容中的关键词。通常关键词的密度为2%-8%。可以使用这种检测方法。网站管理员工具进行检测。 文章的开头和结尾应该有关键词,就像电影的开头和结尾一样,开头和结尾都是照应的。第二部分是技术标签上的关键词。所有网站都应带有一个meta标签。该标签收录:关键字和描述。通过网页源代码工具,您可以看到此标记的表示形式:SEO,搜索引擎优化“ />,搜索引擎优化” />,其中的内容是特定的关键词和说明。这主要是让搜索引擎蜘蛛看到的,以便蜘蛛可以识别网站的内容。

三、链接优化

整个互联网可以说是由数千个链接组成的。 网站链接的优化是允许用户和搜索引擎以最简单的方式找到该网站。这里也有两个方面。第一个方面是网站本身的链接。搜索引擎在早期很难或不友好地识别动态URL。动态URL(例如:,问号是动态符号)比该结构是否是后者更容易理解。但是,随着人工智能等高科技的发展,搜索引擎现在能够识别动态URL,但它们仍然不友好。世界上所有知名的网站基本上都是静态URL。这里提到的静态URL是动态网站的伪静态,而实际的静态URL通常是直接的html文件。

链接优化的另一个方面是外部链接的构建。外部链接可以通过点击其他人的网站来访问我们的网站。外部链接的构建非常困难。如果您在某个方面是名人,那可能会更好。 ,没有人想在他的网站上推荐一个陌生人网站。如果网站的权重较高,则推荐您的网站,那么您的网站的权重也会更高,流量也会更大。实际上,任何搜索引擎都尚未正式认可此权重声明。网站站长工具会根据经验进行观察。例如,爱站具有百度权重值,并且它们根据网站的综合属性分配一定的值。最高值为9。在外部链接的过程中,我们至少需要权重值为5或更大的网站来推荐您,以便您的访问量能够增加。

以上三个方面是搜索引擎优化的核心。本文将不对具体细节进行过多解释。作为SEO从业人员或想进入这个行业的人,他们应该专注于这些方面。此外,该网站还收录Google和百度与SEO相关的知识和技能。您可以使用该网站的搜索功能进行搜索,也可以通过我的微信,微博和电子邮件进行交流。

项目招商找A5快速获取精准代理名单搜索引擎原理中

网站优化 • 优采云 发表了文章 • 0 个评论 • 120 次浏览 • 2021-05-05 02:06

项目投资促进会发现A5可以快速获取准确的代理商清单

按照搜索引擎的原理,搜索引擎工作流程中收录三个主要方面:数据采集,数据预处理和查询服务。在这里,我想与您分享数据预处理。我想知道的是,它涉及一些专业词汇,锚文本已添加到我的博客中,此处没有,如果您不了解原创文本,则可以阅读。

我们提到的“数据预处理”主要包括四个方面:关键词提取,消除“镜像网页”和“重印网页”,链接分析和网页重要性的计算。

关键词提取:

1)在每个章节的网页中,都有许多与主题内容无关的内容,例如版权声明等。关键词提取的任务是提取内容的内容部分。网页的源文件。 k5]。提取方法:通常类似于分词,将内容切成多个单词的数组,然后取出无意义的短语(例如“ zai”和“的”)确定最终的关键词。 (Blogger联想:关键词密度,关键词粗体,定向锚文本因此而出现,这便于搜索引擎做出简单的判断关键词)

在DocView模型中将有更详细的说明,以下各章将对此进行说明。有多个步骤,例如在关键词提取之前进行网页纯化。由于书籍的编辑顺序,我们在此将不对其进行详细说明。有兴趣的人可以单击链接跳至查看:DocView模型,网页净化;

删除重复或重印的网页:

1)天网(Skynet)2003年的统计数据表明,网页的平均重复率为4,到2015年,这个数字必须超过10。对于屏幕名称,他们有更多机会访问有用的信息。对于搜索引擎而言,浪费了大量的时间来采集网页和网络宽带资源。具体的实现方法将在后面讨论。

链接分析:

1)链接分析中提到了两个概念,术语频率(TF):关键词提取后的关键词集合中关键词的出现频率;

2)文档频率(DF):关键词出现在所有文件中的频率,在所有文件中,关键词出现在多少文件中;

3)搜索引擎可以使用HTML文本标签来确定关键词的重要性(联想Blogger:

标签的使用由此衍生);其他文件的链接用于判断(Blogger协会:使用方向锚文字)

网页重要性的计算:

1)搜索引擎需要以列表的形式显示用户索引给客户的结果,并在显示中满足用户的搜索需求,因此出现了“网页重要性”的概念。

2)判断重要性的方法:人们使用评估参考文献重要性的方法,其核心是“引用最多的是最重要的”。这样,它恰好完美地体现在HTML的超文本链接中,并且Google的PR值(引用该页面的页面概述以及引用该页面的页面的重要性)是一个完美的显示方式(Blogger协会:发布链接是算法的完美体现)。 (PageRank算法)

3)与第二点的区别在于,某些页面大量指向其他页面,而某些页面被其他页面大量引用,从而形成对偶关系,因此出现了HITS算法。 (HITS算法)

一些名词的介绍:

”倒排文字:使用文档(收录采集的网页)中收录的关键词作为索引,该文档通常用作索引的着陆页(目标文档),就像在纸质书中一样,索引是文章 关键词,书的特定内容或页面是索引目标页面。

镜像网页:网页内容完全相同,未经任何修改

转载的网页:主要内容基本相同,但添加了少量编辑信息

HITS算法:简介。在HITS算法中,有两个页面的Authority(权威)页面和Hub(目录)页面。对于授权机构页面A,指向页面A的集线器页面H页面越多,质量越高,相同的集线器页面H指向的授权者页面A的数量就越多,并且质量越高,质量就越高。 H页的页面。

Chen Chen最后在搜索引擎原理书中总结了数据预处理的介绍,它收录四个方面。从Chen Chen的角度来看,链接分析用于判断网页的重要性,因此您可以分为三个类别,将其分为一个类别。用一句话:首先消除重复或重印的页面,然后提取关键词,添加DF,TF,链接和算法以确定页面的重要性。

原创来源链接:

申请创业报告并分享创业创意。单击此处,一起讨论新的创业机会! 查看全部

项目招商找A5快速获取精准代理名单搜索引擎原理中

项目投资促进会发现A5可以快速获取准确的代理商清单

按照搜索引擎的原理,搜索引擎工作流程中收录三个主要方面:数据采集,数据预处理和查询服务。在这里,我想与您分享数据预处理。我想知道的是,它涉及一些专业词汇,锚文本已添加到我的博客中,此处没有,如果您不了解原创文本,则可以阅读。

我们提到的“数据预处理”主要包括四个方面:关键词提取,消除“镜像网页”和“重印网页”,链接分析和网页重要性的计算。

关键词提取:

1)在每个章节的网页中,都有许多与主题内容无关的内容,例如版权声明等。关键词提取的任务是提取内容的内容部分。网页的源文件。 k5]。提取方法:通常类似于分词,将内容切成多个单词的数组,然后取出无意义的短语(例如“ zai”和“的”)确定最终的关键词。 (Blogger联想:关键词密度,关键词粗体,定向锚文本因此而出现,这便于搜索引擎做出简单的判断关键词)

在DocView模型中将有更详细的说明,以下各章将对此进行说明。有多个步骤,例如在关键词提取之前进行网页纯化。由于书籍的编辑顺序,我们在此将不对其进行详细说明。有兴趣的人可以单击链接跳至查看:DocView模型,网页净化;

删除重复或重印的网页:

1)天网(Skynet)2003年的统计数据表明,网页的平均重复率为4,到2015年,这个数字必须超过10。对于屏幕名称,他们有更多机会访问有用的信息。对于搜索引擎而言,浪费了大量的时间来采集网页和网络宽带资源。具体的实现方法将在后面讨论。

链接分析:

1)链接分析中提到了两个概念,术语频率(TF):关键词提取后的关键词集合中关键词的出现频率;

2)文档频率(DF):关键词出现在所有文件中的频率,在所有文件中,关键词出现在多少文件中;

3)搜索引擎可以使用HTML文本标签来确定关键词的重要性(联想Blogger:

标签的使用由此衍生);其他文件的链接用于判断(Blogger协会:使用方向锚文字)

网页重要性的计算:

1)搜索引擎需要以列表的形式显示用户索引给客户的结果,并在显示中满足用户的搜索需求,因此出现了“网页重要性”的概念。

2)判断重要性的方法:人们使用评估参考文献重要性的方法,其核心是“引用最多的是最重要的”。这样,它恰好完美地体现在HTML的超文本链接中,并且Google的PR值(引用该页面的页面概述以及引用该页面的页面的重要性)是一个完美的显示方式(Blogger协会:发布链接是算法的完美体现)。 (PageRank算法)

3)与第二点的区别在于,某些页面大量指向其他页面,而某些页面被其他页面大量引用,从而形成对偶关系,因此出现了HITS算法。 (HITS算法)

一些名词的介绍:

”倒排文字:使用文档(收录采集的网页)中收录的关键词作为索引,该文档通常用作索引的着陆页(目标文档),就像在纸质书中一样,索引是文章 关键词,书的特定内容或页面是索引目标页面。

镜像网页:网页内容完全相同,未经任何修改

转载的网页:主要内容基本相同,但添加了少量编辑信息

HITS算法:简介。在HITS算法中,有两个页面的Authority(权威)页面和Hub(目录)页面。对于授权机构页面A,指向页面A的集线器页面H页面越多,质量越高,相同的集线器页面H指向的授权者页面A的数量就越多,并且质量越高,质量就越高。 H页的页面。

Chen Chen最后在搜索引擎原理书中总结了数据预处理的介绍,它收录四个方面。从Chen Chen的角度来看,链接分析用于判断网页的重要性,因此您可以分为三个类别,将其分为一个类别。用一句话:首先消除重复或重印的页面,然后提取关键词,添加DF,TF,链接和算法以确定页面的重要性。

原创来源链接:

申请创业报告并分享创业创意。单击此处,一起讨论新的创业机会!

主题模型是一种页面内容布局的模型(组图)

网站优化 • 优采云 发表了文章 • 0 个评论 • 110 次浏览 • 2021-05-04 00:02

主题模型是页面内容布局的模型,目的是允许搜索引擎正确理解整个页面的核心主题是什么,而不是传达许多关键词主题。因为一个页面可以收录很多信息,所以有些有用,有些则被采用,因此您只能通过将实际的核心信息传递给搜索引擎来获得相应的排名。因此,在主题模型中,我们需要实现一种全新的4步优化方法:

1)词法关联

2)词汇布局

3)补充内容

4)内容属性

对于Wikipedia等熟悉的网站,亚马逊使用其中的积分来获得大量的关键词排名。他们之所以部署在页面布局上,是因为其“框架”足够强大,可以有效地向搜索引擎大量显示核心内容主题。因此,在植入内容之后,可以创建大量最新页面。因此,无论您是白人还是老兵,即使您不了解搜索引擎算法,只要使用主题模型,您都可以排名不错! (特别是对于Google)

1

单词家庭协会

无论您使用哪种方法来优化页面内容,都必须专注于如何关联单词和短语。作为内容编辑器,您撰写的内容最直接影响搜索引擎对页面主题的理解。

当我们使用句子和单词时,搜索引擎将根据其他资源中的数据将您的内容相关联,以生成所谓的内容实体。我们的优化人员首先需要研究关键词,以找出这些句子和单词之间的关系。我相信每个人都有自己的研究方法关键词,但是您需要实现以下目标:

1)查找同义词和变体

2)查找与主要单词内容相关的第二类单词

3)查找与第二种单词相关的三种单词

4)得出结论,内容属性与主题(人,地点,物质)有关

让我举个例子。例如,如果您要优化称为[Internet名人]的关键词,则该词将成为您的主要词。根据目的(1),其同义词和变体词可以是“ 自媒体”,“意见领袖”,“互联网推广”等;根据目的(2),与主题内容可以是“手少”,“微博”,“新单词”;然后根据目的(3)查找与第二种单词相关的三种类型的单词可以是“手少” =粗略的,负面的分数,“微博” =粉丝,向前,“新词” =土豪,这个问题又来了。

您可以清楚地看到单词和短语的每一层之间的某些联系。根据[4),我们尝试在这些内容与内容中的主要词之间建立连接,尤其是在有人,地点和事物存在的情况下。这将有助于搜索引擎建立此类内容实体,因为将存在此类关联在其他网站上(例如,在谈论Shouge时,他会提及他的微博,他的新评论,他的属性等),然后搜索引擎将正确理解您的页面主题。请记住,您正在传递主题,而不是关键词密度!

2

单词家庭布局

毫无疑问,页面的布局对于搜索引擎理解内容主题也非常重要。蜘蛛程序到达页面并找到许多关键词后,有必要区分关键词和相关短语之间哪个重要,哪个重要。因此,词系统的布局是要区分核心词及其相关性。这是3种实用的优化方法:

1)区域:关键词必须出现在标题,标题和主要段落中

2)频率:重要短语或它们的变体出现的次数可能超过平均水平

3)距离:相关的词或短语应彼此靠近或使用HTML元素(例如ALT)

方法(1)是大多数SEO人员的必修项目,我们仍然需要将核心主题词放在标题,标题中,并尽可能多地显示在正文的顶部。

方法(2)此处不是单独指关键词的频率(密度),而是链接频率的更复杂级别,是核心词的同义词和变体。在相同条件下,流行度较低同义词和变体词会获得更好的效果(Google拥有TF-IDF专利,这更难以理解)

方法(3)距离之美不适用于SEO世界。单词,词组或句子应尽可能靠近放置,或使用HTML元素(例如图片ALT设置)。因此,为了提高语言的上下文相关性,应通过段落,列表和分区使内容更明显。您可以一目了然地了解该段落的内容。句子前后之间是否存在连通性,请不要将内容与相似的意思太过分了。因为您无法确保Spider可以捕获全文。

您知道该方法的原理。现在,您要做的是将第二类单词和第三类单词分为不同的区域或段落或短语。目的是支持您的主要单词(排名单词)。前面提到的搜索引擎可以通过大数据区分单词关联。举个简单的例子:

主要词是[Internet名人],第一段将重点放在这个词文章上。第二段使用几只手制作文章,第三段使用微博中继效果制作文章,第四段使用新的互联网名称制作文章。等等。您形成的Web内容是与单词家族相关的内容,单词家族通过第2步进行布局。

3

补充内容

也许很多人认为外部链接是告诉搜索引擎此页面主题的最有力信号。但是我们必须承认,今天的外部链接就像一颗不合时宜的炸弹,它们可能会被链接杀死。因此,搜索引擎希望每个人都可以同时使用内部链接和外部链接,向好的三方网站提出积极的建议,并指导相关的网站内容。健康的网站应该进出,以便用户可以获得更多更好的信息,并且您的网站有意义。

因此,外部链接不是确定内容主题的唯一因素,而是平衡地导入链接和其他补充内容。那么什么是补充内容?从图表中可以看到,如果您的网页与左侧的网页相同,则意味着该类型的网页仅是关键词,缺少文本链接,参考资料和相关资源推荐,因此您的网页非常僵化,这是一个死胡同,这是给你的。该页面没有额外的分数。看一下右边的例子。此页面在内容中同时具有站点内链接(黄色部分)和导出链接。例如,SEO技术是复云的课件,是老师的课件。这是给搜索引擎的消息。我有[补充]。想一想,百度百科还是知道为什么要添加指向相关资源的链接?实际上,这是为了增强页面主题的深化,并通过不同站点的内容来增强信息。这是补充内容,可以为用户提供更好的信息,当然您的页面也将受到搜索引擎的奖励。

1)在页面底部添加到相关资源的链接(建议使用站点链接)

2)在文字中使用引号,例如业内知名人士的文字或图标或视频

3)使用文本中的导出链接转到第三方网站(用K表示,您不会有100个头脑)

4

实体内容

这是一个非常困难的概念,英文为Entity。强大的搜索引擎将在爬网页面时自动解释内容实体,或将其理解为内容属性。例如,在图片的页面上,当内容中提到“文君”时,它是实体[person]吗?当提到“文君信息”时,是[公司]?

在通常情况下,大多数搜索引擎会向网站管理员提供其自己的结构化数据(百度也提供这些数据)。什么是结构化数据?它是使用搜索引擎设置的HTML标记来定义内容,或统称为使用模式。这样,当内容涉及公司时可以使用结构化数据,而在计分时可以使用其他结构化数据。统计数据表明,全世界只有0. 3%网站使用Schema,所以要知道,这太高级了,我们只需要稍微了解一下即可。有机会让您的架构师整合网站结构化数据。

当然,提到的实体仍然是近年来出现的一个概念。过去,每个人都用单词来定义SEO,但现在更多地是针对实体。由于单词排名使用了过多的外部链主导的基于链的方法,因此结果排名始终使用户不满意,尤其是使用百度的用户认为搜索准确性比Google差了几步。

建立内容实体可以解决此问题,因为搜索引擎存储的大量页面数据可以比较“每个实体”之间的相关性。

上一篇文章:编写SEO内容时,除了关键词密度外,如何保持样式?下一篇:网站 SEO优化应该抓住基因,在内容营销中做得很好 查看全部

主题模型是一种页面内容布局的模型(组图)

主题模型是页面内容布局的模型,目的是允许搜索引擎正确理解整个页面的核心主题是什么,而不是传达许多关键词主题。因为一个页面可以收录很多信息,所以有些有用,有些则被采用,因此您只能通过将实际的核心信息传递给搜索引擎来获得相应的排名。因此,在主题模型中,我们需要实现一种全新的4步优化方法:

1)词法关联

2)词汇布局

3)补充内容

4)内容属性

对于Wikipedia等熟悉的网站,亚马逊使用其中的积分来获得大量的关键词排名。他们之所以部署在页面布局上,是因为其“框架”足够强大,可以有效地向搜索引擎大量显示核心内容主题。因此,在植入内容之后,可以创建大量最新页面。因此,无论您是白人还是老兵,即使您不了解搜索引擎算法,只要使用主题模型,您都可以排名不错! (特别是对于Google)

1

单词家庭协会

无论您使用哪种方法来优化页面内容,都必须专注于如何关联单词和短语。作为内容编辑器,您撰写的内容最直接影响搜索引擎对页面主题的理解。

当我们使用句子和单词时,搜索引擎将根据其他资源中的数据将您的内容相关联,以生成所谓的内容实体。我们的优化人员首先需要研究关键词,以找出这些句子和单词之间的关系。我相信每个人都有自己的研究方法关键词,但是您需要实现以下目标:

1)查找同义词和变体

2)查找与主要单词内容相关的第二类单词

3)查找与第二种单词相关的三种单词

4)得出结论,内容属性与主题(人,地点,物质)有关

让我举个例子。例如,如果您要优化称为[Internet名人]的关键词,则该词将成为您的主要词。根据目的(1),其同义词和变体词可以是“ 自媒体”,“意见领袖”,“互联网推广”等;根据目的(2),与主题内容可以是“手少”,“微博”,“新单词”;然后根据目的(3)查找与第二种单词相关的三种类型的单词可以是“手少” =粗略的,负面的分数,“微博” =粉丝,向前,“新词” =土豪,这个问题又来了。

您可以清楚地看到单词和短语的每一层之间的某些联系。根据[4),我们尝试在这些内容与内容中的主要词之间建立连接,尤其是在有人,地点和事物存在的情况下。这将有助于搜索引擎建立此类内容实体,因为将存在此类关联在其他网站上(例如,在谈论Shouge时,他会提及他的微博,他的新评论,他的属性等),然后搜索引擎将正确理解您的页面主题。请记住,您正在传递主题,而不是关键词密度!

2

单词家庭布局

毫无疑问,页面的布局对于搜索引擎理解内容主题也非常重要。蜘蛛程序到达页面并找到许多关键词后,有必要区分关键词和相关短语之间哪个重要,哪个重要。因此,词系统的布局是要区分核心词及其相关性。这是3种实用的优化方法:

1)区域:关键词必须出现在标题,标题和主要段落中

2)频率:重要短语或它们的变体出现的次数可能超过平均水平

3)距离:相关的词或短语应彼此靠近或使用HTML元素(例如ALT)

方法(1)是大多数SEO人员的必修项目,我们仍然需要将核心主题词放在标题,标题中,并尽可能多地显示在正文的顶部。

方法(2)此处不是单独指关键词的频率(密度),而是链接频率的更复杂级别,是核心词的同义词和变体。在相同条件下,流行度较低同义词和变体词会获得更好的效果(Google拥有TF-IDF专利,这更难以理解)

方法(3)距离之美不适用于SEO世界。单词,词组或句子应尽可能靠近放置,或使用HTML元素(例如图片ALT设置)。因此,为了提高语言的上下文相关性,应通过段落,列表和分区使内容更明显。您可以一目了然地了解该段落的内容。句子前后之间是否存在连通性,请不要将内容与相似的意思太过分了。因为您无法确保Spider可以捕获全文。

您知道该方法的原理。现在,您要做的是将第二类单词和第三类单词分为不同的区域或段落或短语。目的是支持您的主要单词(排名单词)。前面提到的搜索引擎可以通过大数据区分单词关联。举个简单的例子:

主要词是[Internet名人],第一段将重点放在这个词文章上。第二段使用几只手制作文章,第三段使用微博中继效果制作文章,第四段使用新的互联网名称制作文章。等等。您形成的Web内容是与单词家族相关的内容,单词家族通过第2步进行布局。

3

补充内容

也许很多人认为外部链接是告诉搜索引擎此页面主题的最有力信号。但是我们必须承认,今天的外部链接就像一颗不合时宜的炸弹,它们可能会被链接杀死。因此,搜索引擎希望每个人都可以同时使用内部链接和外部链接,向好的三方网站提出积极的建议,并指导相关的网站内容。健康的网站应该进出,以便用户可以获得更多更好的信息,并且您的网站有意义。