抓取网页音频

抓取网页音频(Scrapy爬虫框架中meta参数的使用示例演示(上))

网站优化 • 优采云 发表了文章 • 0 个评论 • 85 次浏览 • 2022-04-08 02:00

上一阶段我们已经实现了通过Scrapy抓取特定网页的具体信息,Scrapy爬虫框架中元参数的使用演示(上),以及Scrapy爬虫中元参数的使用演示框架(下),但没有实现所有页面的顺序获取。首先,我们来看看爬取的思路。大致思路是:当获取到第一页的URL后,再将第二页的URL发送给Scrapy,这样Scrapy就可以自动下载该页的信息,然后传递第二页的URL。URL继续获取第三页的URL。由于每个页面的网页结构是一致的,这样就可以通过反复迭代来实现对整个网页的信息提取。具体实现过程将通过Scrapy框架实现。具体教程如下。

/执行/

1、首先,URL不再是特定文章的URL,而是所有文章列表的URL,如下图,把链接放在start_urls中,如下图所示。

2、接下来我们需要改变 parse() 函数,在这个函数中我们需要实现两件事。

一种是获取一个页面上所有文章的URL并解析,得到每个文章中具体的网页内容,另一种是获取下一个网页的URL并手它交给 Scrapy 进行处理。下载,下载完成后交给parse()函数。

有了前面 Xpath 和 CSS 选择器的基础知识,获取网页链接 URL 就相对简单了。

3、分析网页结构,使用网页交互工具,我们可以很快发现每个网页有20个文章,也就是20个URL,文章的列表存在于id="archive" 标签,然后像剥洋葱一样得到我们想要的 URL 链接。

4、点击下拉三角形,不难发现详情页的链接并没有隐藏很深,如下图圆圈所示。

5、根据标签,我们将根据图片搜索地图,并添加选择器工具,获取URL就像搜索东西一样。在cmd中输入以下命令进入shell调试窗口,事半功倍。再次声明,这个URL是所有文章的URL,而不是某个文章的URL,否则调试半天也得不到结果。

6、根据第四步的网页结构分析,我们在shell中编写CSS表达式并输出,如下图所示。其中a::attr(href)的用法很巧妙,也是提取标签信息的一个小技巧。建议朋友在提取网页信息的时候可以经常使用,非常方便。

至此,第一页所有文章列表的url都获取到了。 查看全部

抓取网页音频(Scrapy爬虫框架中meta参数的使用示例演示(上))

上一阶段我们已经实现了通过Scrapy抓取特定网页的具体信息,Scrapy爬虫框架中元参数的使用演示(上),以及Scrapy爬虫中元参数的使用演示框架(下),但没有实现所有页面的顺序获取。首先,我们来看看爬取的思路。大致思路是:当获取到第一页的URL后,再将第二页的URL发送给Scrapy,这样Scrapy就可以自动下载该页的信息,然后传递第二页的URL。URL继续获取第三页的URL。由于每个页面的网页结构是一致的,这样就可以通过反复迭代来实现对整个网页的信息提取。具体实现过程将通过Scrapy框架实现。具体教程如下。

/执行/

1、首先,URL不再是特定文章的URL,而是所有文章列表的URL,如下图,把链接放在start_urls中,如下图所示。

2、接下来我们需要改变 parse() 函数,在这个函数中我们需要实现两件事。

一种是获取一个页面上所有文章的URL并解析,得到每个文章中具体的网页内容,另一种是获取下一个网页的URL并手它交给 Scrapy 进行处理。下载,下载完成后交给parse()函数。

有了前面 Xpath 和 CSS 选择器的基础知识,获取网页链接 URL 就相对简单了。

3、分析网页结构,使用网页交互工具,我们可以很快发现每个网页有20个文章,也就是20个URL,文章的列表存在于id="archive" 标签,然后像剥洋葱一样得到我们想要的 URL 链接。

4、点击下拉三角形,不难发现详情页的链接并没有隐藏很深,如下图圆圈所示。

5、根据标签,我们将根据图片搜索地图,并添加选择器工具,获取URL就像搜索东西一样。在cmd中输入以下命令进入shell调试窗口,事半功倍。再次声明,这个URL是所有文章的URL,而不是某个文章的URL,否则调试半天也得不到结果。

6、根据第四步的网页结构分析,我们在shell中编写CSS表达式并输出,如下图所示。其中a::attr(href)的用法很巧妙,也是提取标签信息的一个小技巧。建议朋友在提取网页信息的时候可以经常使用,非常方便。

至此,第一页所有文章列表的url都获取到了。

抓取网页音频(>百度蜘蛛是什么意思?调度程序来调度和指挥)

网站优化 • 优采云 发表了文章 • 0 个评论 • 82 次浏览 • 2022-04-04 22:20

>

百度蜘蛛是什么意思?很多新手总会听到有人说起百度蜘蛛。乍一听有些迷惑,好像他们知道是什么情况,但也不是很清楚。下面详细介绍一下什么是百度蜘蛛。

什么是百度蜘蛛?

在了解百度蜘蛛之前,我们需要了解什么是网络。其实,我们所说的网络,一般是指互联网。我们可以把网络比作一个巨大无边的蜘蛛网,而网站可以比作这个蜘蛛网上的每个节点,节点上需要采集什么信息,有一个“蜘蛛”自动化程序。例如,百度“蜘蛛”就是百度搜索引擎的定义。深圳代理记账

百度蜘蛛是百度搜索引擎中的一个自动化程序,是搜索引擎的核心技术。它的功能是通过URL访问和爬取互联网上的网页、视频、图片和音频。搜索引擎构建了一个调度器来调度和指挥百度蜘蛛工作,而百度蜘蛛只下载网页。

百度蜘蛛分类

经过多年的更新,百度也对不同的网站给出了不同的蜘蛛分类,让这些蜘蛛可以有效判断网站的价值。百度蜘蛛一般分为3类:高级蜘蛛、中级蜘蛛和初级蜘蛛。每种蜘蛛对网站都有不同的分工,就像我们人类的位置一样。深圳代理记账

(1)高级蜘蛛:这个蜘蛛只会爬一些高权重的网站。我们经常会发现为什么其他大的网站出站链接会秒收到,而我们自己的网站 而不是收录。原因是高级蜘蛛在爬取网站时有各种优先级,比如访问率高、爬取深度高、收录快好排名等等。

(2)中级蜘蛛:这个蜘蛛会通过一些网站友情链接和外部链接进入一个新的网站,然后再判断新的网站,比如新的< @网站内容是否优质,原创,删除部分低质量内容。

(3)小蜘蛛:小蜘蛛就像一个小门槛,要求不高,审稿频率也不高,只会过滤一些新站,过一段时间就会是否值得发布,主要原因是新的网站太多,而好的新网站很少。互联网提供优质内容,新的网站过不了审核期的@>,自然不会。放手吧。这种情况一般称为沙盒期,这也是很多新网站坚持不下来的原因。深圳公司注册

百度蜘蛛运行原理

搜索引擎调度器发出指令---百度蜘蛛开始爬取工作---通过URL与服务器建立连接,爬取、访问、爬取和下载网页并存储在补充数据区(文件存储)中—— --调度器调用索引程序算法对下载的网页进行预处理和爬取--将符合规则的网页放入检索区--显示排名。

1、预处理:对搜索引擎蜘蛛爬取下载的页面进行文本提取、链接提取、中文分词。

2、网页排名展示:当用户搜索关键词时,调度排名程序对数据库进行索引,计算相关性,然后生成一定格式的搜索结果页面。

3、爬取和爬取是搜索引擎工作的第一步,完成网页的爬取、爬取、数据采集任务。今天的搜索引擎蜘蛛在爬取过程中也在一定程度上进行内容检查和检测。在低权重的情况下,大量其他人的网站内容、原创度低、质量差的网页可能不再被抓取。

百度蜘蛛预处理

预处理是搜索引擎工作中最重要的一步,包括以下算法处理:

为什么要预处理?搜索引擎蜘蛛抓取存储的原创页面,不能直接用于排名查询。数据量太大,无法在毫秒内将结果返回给用户。因此,必须对原创页面进行预处理以对后续查询进行排名。准备。

1、提取原创网页文本

搜索引擎预处理首先要做的是从 HTML 页面中去除各种标签、程序和文本,这些标签、程序和文本可用于页面排名。但除了文本之外,它还会提取一些收录文本信息的特殊代码,例如元标记、TITLE 标记、DESCRITION、KEYWORDS、aLT、链接中的锚文本。

2、中文分词

中文分词是中文搜索引擎特有的一步,因为中文不像英文,词之间有空格,所有词都是连在一起的,这就需要搜索引擎区分哪些词组成一个词,词本身就是一个词. 例如:seo优化教程会分为SEO优化、教程两个词。

中文分词的两种方法:字典匹配和统计匹配。统计匹配是通过计算单词之间相邻出现的频率来计算的。深圳公司注册

搜索引擎对页面的分词取决于词库的大小和准确性,以及分词算法的质量,而不是页面本身的情况。SEOER能做的很少,唯一能做的就是在页面上以某种形式提示搜索引擎。例如,关键词 出现在标题、H1 等标签和粗体中。

点击查看百度截图,大致可以看到搜索引擎是如何分词的

知道分词的原理,做锚文本外链效率更高。例如:比如搜索引擎优化,当分成三个词进行搜索引擎优化时,分别制作三个词的锚文本链接,以提高搜索引擎优化的效果。. 如果直接用SEO做锚文本,排名不是那么好。

3、寻找停用词

无论是中文搜索引擎还是因为搜索引擎,都会有一些词出现在页面上的频率很高,但对内容没有任何影响。搜索引擎会在预处理的过程中去掉这些词,使索引数据突出,减少不必要的计算量。

在预处理过程中,索引引擎会将这些词去掉,从而突出索引数据,减少不必要的计算量。

4、去除噪音

除了停用词之外,还有一些对页面主题没有贡献的内容,比如版权声明、导航栏、广告等,这些都是噪音,只能在页面上起到分散注意力的作用。

消除噪音的基本方法是根据HTML标签将页面分成块,区分页眉、页脚、导航、文本、广告等区域。网站 上重复出现的块通常是嘈杂的,这对噪声非常有害。去噪后,剩下的是网页的主题内容。

5、删除

对于不喜欢相同内容出现在不同的网站和相同的网站 URL的用户和搜索引擎,搜索引擎需要识别并删除这些重复的内容。这个过程就是重复数据删除。

去重的基本方法是计算页面特征关键词的指纹,也就是选择文章中出现频率最高的部分(即分词、停用词、去噪后)关键词,通常选择10个左右的特征关键词可以达到很高的计算精度。

对于一些不断增加且与文章无关的词,所谓的伪原创逃不过搜索引擎的去重算法。这样做不会改变 关键词 的特性。搜索引擎的重复数据删除算法可能不仅在页面级别,而且在段落级别。

百度蜘蛛笔记

1、搜索引擎蜘蛛的爬取爬取只是搜索引擎工作的第一步,也就是完成数据采集的任务。

2、当搜索引擎蜘蛛访问任何一个网站时,它会首先访问网站根目录下的ROBOTS文件,检查是否只允许搜索引擎蜘蛛爬行。

3、无论是浏览器还是搜索引擎蜘蛛或其他访问程序,都会标明自己的身份代理名称,即USER-aGENT:

4、文件存储:搜索引擎蜘蛛爬取的数据存储在数据库中,获取的数据与浏览器获取的HTML完全相同,每个URL都会标有自己唯一的文件号。

5、百度搜索引擎调度器原理,告诉和调度搜索引擎蜘蛛应该抓取和下载什么样的网页,如何发现网页,发现更多的网页;

6、链接跟踪:为了爬取更多的页面,搜索引擎蜘蛛会跟踪页面上的所有链接,并沿着链接继续爬取。

7、深度优先:表示蜘蛛沿着找到的链接向前爬行,直到前面没有其他链接,然后返回第一页,沿着另一个链接继续爬行。是指互联网上一些知名的、深度较深的门户网站,优先爬取,通过这些网站,搜索引擎蜘蛛可以爬取更多的优质网页。

8、广度优先:当搜索引擎蜘蛛在一个页面上发现多个链接时,它并没有一路顺着这些链接前进,而是先抓取页面上所有的一级链接,然后再抓取二级——级链接。

9、权重优先:表示反向链接较多的页面优先抓取。一般情况下,40%的网页在正常范围内被爬取,60%认为是好的,100%是不可能的。

10、百度蜘蛛只负责数据补充区的爬取、访问、爬取、下载、存储。优先级和权重的原则由搜索引擎调度器计算和分配。

百度搜索引擎蜘蛛的工作要素

在深度优先和权重优先的机制下,百度蜘蛛最终访问并抢到了网站。百度蜘蛛爬取下载到网页首页后,调度器会计算网页中所有的url,然后继续返回百度蜘蛛抓取下一个链接列表,继续抓取下载更多的网页。(称为跟踪链接,以便在 Internet 上抓取尽可能多的页面)。

百度蜘蛛有效爬取方式:地图

为什么要在首页做百度地图的入口?可以用百度地图给百度蜘蛛一个爬的方向,让百度知道哪些页面是重要的。您还可以在主页上建立更多的链接入口。页面越多指向该页面,首页指向该页面,栏目指向该页面,可以提高该页面的优先爬取和快速爬取。

地图的另一个作用是让搜索引擎蜘蛛爬取更多的网页。

地图其实是提供给百度蜘蛛的一个连接列表,用来计算你的目录结构,找到通过站内连接构建的重要页面。

_创新互联,为您提供App开发、品牌网站搭建、软件开发、面包屑导航、电子商务、网站设计 查看全部

抓取网页音频(>百度蜘蛛是什么意思?调度程序来调度和指挥)

>

百度蜘蛛是什么意思?很多新手总会听到有人说起百度蜘蛛。乍一听有些迷惑,好像他们知道是什么情况,但也不是很清楚。下面详细介绍一下什么是百度蜘蛛。

什么是百度蜘蛛?

在了解百度蜘蛛之前,我们需要了解什么是网络。其实,我们所说的网络,一般是指互联网。我们可以把网络比作一个巨大无边的蜘蛛网,而网站可以比作这个蜘蛛网上的每个节点,节点上需要采集什么信息,有一个“蜘蛛”自动化程序。例如,百度“蜘蛛”就是百度搜索引擎的定义。深圳代理记账

百度蜘蛛是百度搜索引擎中的一个自动化程序,是搜索引擎的核心技术。它的功能是通过URL访问和爬取互联网上的网页、视频、图片和音频。搜索引擎构建了一个调度器来调度和指挥百度蜘蛛工作,而百度蜘蛛只下载网页。

百度蜘蛛分类

经过多年的更新,百度也对不同的网站给出了不同的蜘蛛分类,让这些蜘蛛可以有效判断网站的价值。百度蜘蛛一般分为3类:高级蜘蛛、中级蜘蛛和初级蜘蛛。每种蜘蛛对网站都有不同的分工,就像我们人类的位置一样。深圳代理记账

(1)高级蜘蛛:这个蜘蛛只会爬一些高权重的网站。我们经常会发现为什么其他大的网站出站链接会秒收到,而我们自己的网站 而不是收录。原因是高级蜘蛛在爬取网站时有各种优先级,比如访问率高、爬取深度高、收录快好排名等等。

(2)中级蜘蛛:这个蜘蛛会通过一些网站友情链接和外部链接进入一个新的网站,然后再判断新的网站,比如新的< @网站内容是否优质,原创,删除部分低质量内容。

(3)小蜘蛛:小蜘蛛就像一个小门槛,要求不高,审稿频率也不高,只会过滤一些新站,过一段时间就会是否值得发布,主要原因是新的网站太多,而好的新网站很少。互联网提供优质内容,新的网站过不了审核期的@>,自然不会。放手吧。这种情况一般称为沙盒期,这也是很多新网站坚持不下来的原因。深圳公司注册

百度蜘蛛运行原理

搜索引擎调度器发出指令---百度蜘蛛开始爬取工作---通过URL与服务器建立连接,爬取、访问、爬取和下载网页并存储在补充数据区(文件存储)中—— --调度器调用索引程序算法对下载的网页进行预处理和爬取--将符合规则的网页放入检索区--显示排名。

1、预处理:对搜索引擎蜘蛛爬取下载的页面进行文本提取、链接提取、中文分词。

2、网页排名展示:当用户搜索关键词时,调度排名程序对数据库进行索引,计算相关性,然后生成一定格式的搜索结果页面。

3、爬取和爬取是搜索引擎工作的第一步,完成网页的爬取、爬取、数据采集任务。今天的搜索引擎蜘蛛在爬取过程中也在一定程度上进行内容检查和检测。在低权重的情况下,大量其他人的网站内容、原创度低、质量差的网页可能不再被抓取。

百度蜘蛛预处理

预处理是搜索引擎工作中最重要的一步,包括以下算法处理:

为什么要预处理?搜索引擎蜘蛛抓取存储的原创页面,不能直接用于排名查询。数据量太大,无法在毫秒内将结果返回给用户。因此,必须对原创页面进行预处理以对后续查询进行排名。准备。

1、提取原创网页文本

搜索引擎预处理首先要做的是从 HTML 页面中去除各种标签、程序和文本,这些标签、程序和文本可用于页面排名。但除了文本之外,它还会提取一些收录文本信息的特殊代码,例如元标记、TITLE 标记、DESCRITION、KEYWORDS、aLT、链接中的锚文本。

2、中文分词

中文分词是中文搜索引擎特有的一步,因为中文不像英文,词之间有空格,所有词都是连在一起的,这就需要搜索引擎区分哪些词组成一个词,词本身就是一个词. 例如:seo优化教程会分为SEO优化、教程两个词。

中文分词的两种方法:字典匹配和统计匹配。统计匹配是通过计算单词之间相邻出现的频率来计算的。深圳公司注册

搜索引擎对页面的分词取决于词库的大小和准确性,以及分词算法的质量,而不是页面本身的情况。SEOER能做的很少,唯一能做的就是在页面上以某种形式提示搜索引擎。例如,关键词 出现在标题、H1 等标签和粗体中。

点击查看百度截图,大致可以看到搜索引擎是如何分词的

知道分词的原理,做锚文本外链效率更高。例如:比如搜索引擎优化,当分成三个词进行搜索引擎优化时,分别制作三个词的锚文本链接,以提高搜索引擎优化的效果。. 如果直接用SEO做锚文本,排名不是那么好。

3、寻找停用词

无论是中文搜索引擎还是因为搜索引擎,都会有一些词出现在页面上的频率很高,但对内容没有任何影响。搜索引擎会在预处理的过程中去掉这些词,使索引数据突出,减少不必要的计算量。

在预处理过程中,索引引擎会将这些词去掉,从而突出索引数据,减少不必要的计算量。

4、去除噪音

除了停用词之外,还有一些对页面主题没有贡献的内容,比如版权声明、导航栏、广告等,这些都是噪音,只能在页面上起到分散注意力的作用。

消除噪音的基本方法是根据HTML标签将页面分成块,区分页眉、页脚、导航、文本、广告等区域。网站 上重复出现的块通常是嘈杂的,这对噪声非常有害。去噪后,剩下的是网页的主题内容。

5、删除

对于不喜欢相同内容出现在不同的网站和相同的网站 URL的用户和搜索引擎,搜索引擎需要识别并删除这些重复的内容。这个过程就是重复数据删除。

去重的基本方法是计算页面特征关键词的指纹,也就是选择文章中出现频率最高的部分(即分词、停用词、去噪后)关键词,通常选择10个左右的特征关键词可以达到很高的计算精度。

对于一些不断增加且与文章无关的词,所谓的伪原创逃不过搜索引擎的去重算法。这样做不会改变 关键词 的特性。搜索引擎的重复数据删除算法可能不仅在页面级别,而且在段落级别。

百度蜘蛛笔记

1、搜索引擎蜘蛛的爬取爬取只是搜索引擎工作的第一步,也就是完成数据采集的任务。

2、当搜索引擎蜘蛛访问任何一个网站时,它会首先访问网站根目录下的ROBOTS文件,检查是否只允许搜索引擎蜘蛛爬行。

3、无论是浏览器还是搜索引擎蜘蛛或其他访问程序,都会标明自己的身份代理名称,即USER-aGENT:

4、文件存储:搜索引擎蜘蛛爬取的数据存储在数据库中,获取的数据与浏览器获取的HTML完全相同,每个URL都会标有自己唯一的文件号。

5、百度搜索引擎调度器原理,告诉和调度搜索引擎蜘蛛应该抓取和下载什么样的网页,如何发现网页,发现更多的网页;

6、链接跟踪:为了爬取更多的页面,搜索引擎蜘蛛会跟踪页面上的所有链接,并沿着链接继续爬取。

7、深度优先:表示蜘蛛沿着找到的链接向前爬行,直到前面没有其他链接,然后返回第一页,沿着另一个链接继续爬行。是指互联网上一些知名的、深度较深的门户网站,优先爬取,通过这些网站,搜索引擎蜘蛛可以爬取更多的优质网页。

8、广度优先:当搜索引擎蜘蛛在一个页面上发现多个链接时,它并没有一路顺着这些链接前进,而是先抓取页面上所有的一级链接,然后再抓取二级——级链接。

9、权重优先:表示反向链接较多的页面优先抓取。一般情况下,40%的网页在正常范围内被爬取,60%认为是好的,100%是不可能的。

10、百度蜘蛛只负责数据补充区的爬取、访问、爬取、下载、存储。优先级和权重的原则由搜索引擎调度器计算和分配。

百度搜索引擎蜘蛛的工作要素

在深度优先和权重优先的机制下,百度蜘蛛最终访问并抢到了网站。百度蜘蛛爬取下载到网页首页后,调度器会计算网页中所有的url,然后继续返回百度蜘蛛抓取下一个链接列表,继续抓取下载更多的网页。(称为跟踪链接,以便在 Internet 上抓取尽可能多的页面)。

百度蜘蛛有效爬取方式:地图

为什么要在首页做百度地图的入口?可以用百度地图给百度蜘蛛一个爬的方向,让百度知道哪些页面是重要的。您还可以在主页上建立更多的链接入口。页面越多指向该页面,首页指向该页面,栏目指向该页面,可以提高该页面的优先爬取和快速爬取。

地图的另一个作用是让搜索引擎蜘蛛爬取更多的网页。

地图其实是提供给百度蜘蛛的一个连接列表,用来计算你的目录结构,找到通过站内连接构建的重要页面。

_创新互联,为您提供App开发、品牌网站搭建、软件开发、面包屑导航、电子商务、网站设计

抓取网页音频(如何在微博网页上下载视频和音频,却不是一件)

网站优化 • 优采云 发表了文章 • 0 个评论 • 584 次浏览 • 2022-04-02 10:01

微博是一个社交网络平台,许多人使用它来分享简短的实时信息。微博上有丰富的信息,包括新闻、视频和音乐,有时还会在工作中使用微博上的资料。但是,在微博页面上下载视频和音频并不容易。

今天给大家分享一个好用的下载工具——IDM。它可以帮助我们更方便地下载微博页面上的相关资料,包括图片、音视频等。

1、下载视频

IDM(即Internet Download Manager)是一款功能非常强大的下载软件。它的下载速度比一般的下载工具快,可以解决很多网站限制的问题,包括一些会员视频和音乐。它下载。

使用本软件前,需要在其中文网站上下载安装包。输入网站,点击上方“下载”进入下载页面,下载软件试用版。

下载后,安装软件。安装完成后会有扩展安装提醒。打开目标浏览器,按照操作步骤安装IDM扩展,以便在后续下载过程中调用该软件。

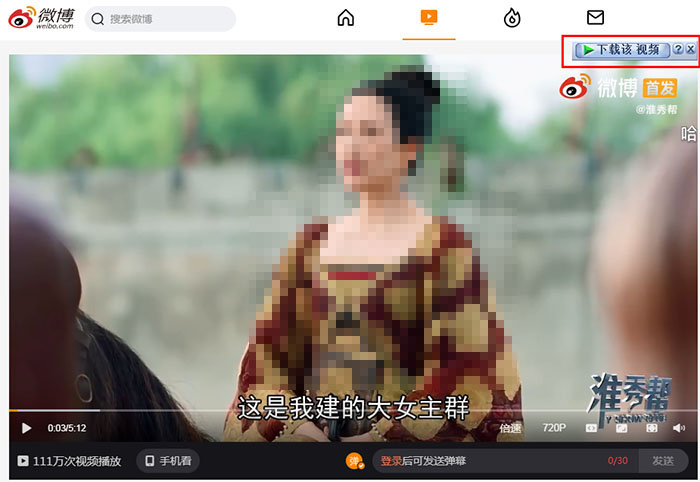

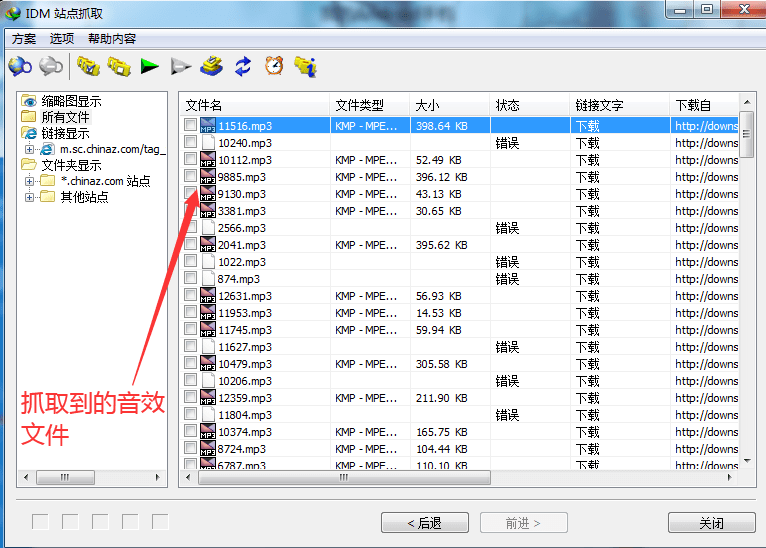

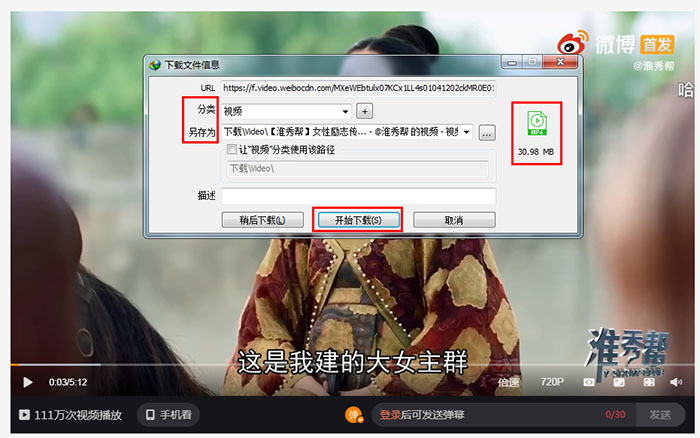

打开微博网页,找到目标视频。这里以某博主制作的视频《女子励志传奇》大女主群聊为例,点击播放视频,视频右上角会出现IDM下载栏。

图1:微博视频

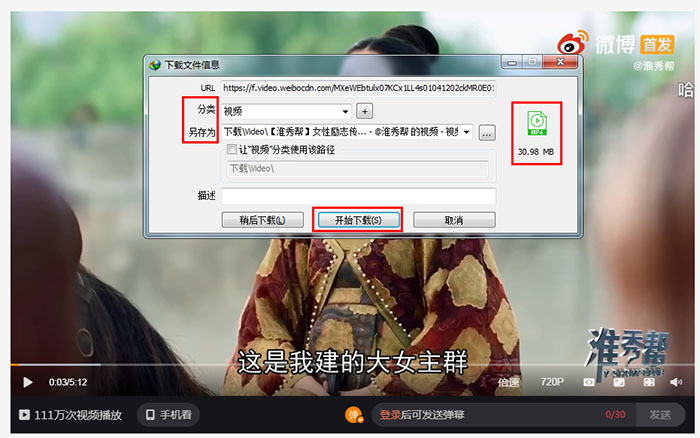

点击下载栏后,会弹出下载对话框,在其中可以看到下载文件的分类、格式、存储名称和位置。如需修改,可在此对话框中直接修改。然后点击“开始下载”。

图 2:下载对话框

下载完成后会自动弹出提示框,然后可以进行“打开”、“打开文件夹”或“关闭”等操作。当然,您也可以在软件首页查看文件的下载状态。

图 3:下载完成

2、下载音频

除了视频,微博上也有非常丰富的音频资源。如果遇到喜欢的音乐,也可以通过IDM下载。

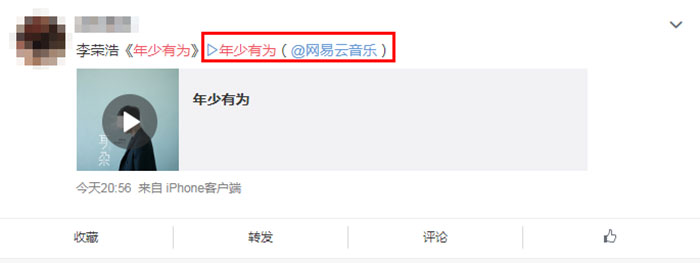

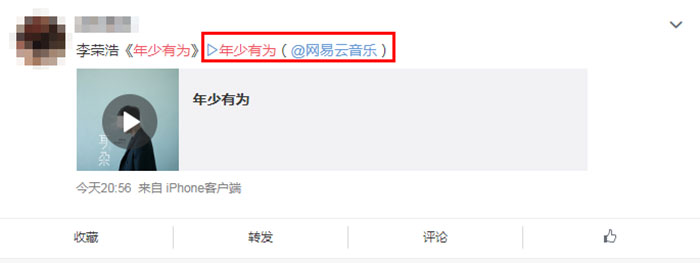

找到目标音频,这里以网易云音乐分享的歌曲《青春在做》为例。点击播放按钮会自动跳转到网易云音乐的网页。

图4:微博音频

进入网易云音乐网页,点击播放按钮,页面右上角会出现IDM下载栏,点击下载音频。

图 5:下载音频

点击后类似于下载视频,会弹出下载对话框。如果不需要修改参数,直接点击“开始下载”,下载完成后直接打开即可。

以上是微博网页下载视频和音频的方法。通过下载工具IDM,简化了下载过程,提高了效率。需要下载的朋友可以到IDM中文网站下载试用版试试看。

(素材来自微博) 查看全部

抓取网页音频(如何在微博网页上下载视频和音频,却不是一件)

微博是一个社交网络平台,许多人使用它来分享简短的实时信息。微博上有丰富的信息,包括新闻、视频和音乐,有时还会在工作中使用微博上的资料。但是,在微博页面上下载视频和音频并不容易。

今天给大家分享一个好用的下载工具——IDM。它可以帮助我们更方便地下载微博页面上的相关资料,包括图片、音视频等。

1、下载视频

IDM(即Internet Download Manager)是一款功能非常强大的下载软件。它的下载速度比一般的下载工具快,可以解决很多网站限制的问题,包括一些会员视频和音乐。它下载。

使用本软件前,需要在其中文网站上下载安装包。输入网站,点击上方“下载”进入下载页面,下载软件试用版。

下载后,安装软件。安装完成后会有扩展安装提醒。打开目标浏览器,按照操作步骤安装IDM扩展,以便在后续下载过程中调用该软件。

打开微博网页,找到目标视频。这里以某博主制作的视频《女子励志传奇》大女主群聊为例,点击播放视频,视频右上角会出现IDM下载栏。

图1:微博视频

点击下载栏后,会弹出下载对话框,在其中可以看到下载文件的分类、格式、存储名称和位置。如需修改,可在此对话框中直接修改。然后点击“开始下载”。

图 2:下载对话框

下载完成后会自动弹出提示框,然后可以进行“打开”、“打开文件夹”或“关闭”等操作。当然,您也可以在软件首页查看文件的下载状态。

图 3:下载完成

2、下载音频

除了视频,微博上也有非常丰富的音频资源。如果遇到喜欢的音乐,也可以通过IDM下载。

找到目标音频,这里以网易云音乐分享的歌曲《青春在做》为例。点击播放按钮会自动跳转到网易云音乐的网页。

图4:微博音频

进入网易云音乐网页,点击播放按钮,页面右上角会出现IDM下载栏,点击下载音频。

图 5:下载音频

点击后类似于下载视频,会弹出下载对话框。如果不需要修改参数,直接点击“开始下载”,下载完成后直接打开即可。

以上是微博网页下载视频和音频的方法。通过下载工具IDM,简化了下载过程,提高了效率。需要下载的朋友可以到IDM中文网站下载试用版试试看。

(素材来自微博)

抓取网页音频(第三方云下载,比较简单的有两种:直接录制sougou云音乐下载器)

网站优化 • 优采云 发表了文章 • 0 个评论 • 210 次浏览 • 2022-04-01 07:03

抓取网页音频下载方法-第三方云下载,

比较简单的有两种:直接录制

sougou云音乐下载器v4.6

sougou云音乐电台下载器很简单啊,可以利用wps快速完成,比如电台下载为word格式,jpg格式。

手机上有一个叫“油兔不二家”的软件,

很爽。

广州amplayer

youtube视频下载,人人都是产品经理,然后录制下去。录制到mp3或者wav格式的,然后找到相应的下载工具,就可以了。但是,如果视频你下载下来看不了,原因就是电脑中没有安装相应的文件。

下载网易云音乐资源到电脑

可以参考一下我这个方法itunes电台下载教程

请用某某云盘中的音乐文件进行下载,而且只能下载在云盘里的视频文件,而你非要下载ios端电台的话,只能下载ios端的电台了。

windows下有个geogebra软件,支持doublestrings,你可以试试。

云音乐客户端,

百度云某某音乐会员号关注公众号:“小羽私塾”回复:“云音乐”即可免费获取pc端和苹果手机端的下载链接哦!

360云盘

windows平台的,你可以用“-%e5%b8%a8%e4%bd%94%e7%89%86%e8%af%9f%e8%af%9f%e7%9b%b4%e7%bd%b4%e8%8f%8d%e7%89%86%e8%a7%86%e8%a8%81-%e4%bd%a1%e5%91%8b%e8%bf%b1%e5%ba%8d%e6%90%96%e7%9a%84%e9%98%90%e7%9a%84%e9%a3%8f%e5%83%9f%e8%bf%8b%e4%b8%8a%e5%90%92%e6%b6%ac%e5%86%88%e5%99%8f%e6%bb%98%e4%bd%a3%e4%ba%a5%e7%99%a5%e7%9a%84%e5%83%86%e6%9d%8f%e6%9d%a0%e7%9b%b4%e4%ba%b7%e5%85%8d%e6%8e%ae%e5%81%ab%e5%a8%a5%e7%89%86%e5%8b%8e%e8%8d%bb%e8%8d%92%e7%9a%84%e7%9a%84%e7%9a%84%e7%9a%84%e9%85%85%e6%81%86%e6%b0%97%e7%9a%84%e9%b1%91%e7%9a%84%e9%99%a7%e7%9a%84%e8%af%86%e7%9a%84%e9%8a%84%e7%9a%84%e7%9a%84%e8%b7%86%e。 查看全部

抓取网页音频(第三方云下载,比较简单的有两种:直接录制sougou云音乐下载器)

抓取网页音频下载方法-第三方云下载,

比较简单的有两种:直接录制

sougou云音乐下载器v4.6

sougou云音乐电台下载器很简单啊,可以利用wps快速完成,比如电台下载为word格式,jpg格式。

手机上有一个叫“油兔不二家”的软件,

很爽。

广州amplayer

youtube视频下载,人人都是产品经理,然后录制下去。录制到mp3或者wav格式的,然后找到相应的下载工具,就可以了。但是,如果视频你下载下来看不了,原因就是电脑中没有安装相应的文件。

下载网易云音乐资源到电脑

可以参考一下我这个方法itunes电台下载教程

请用某某云盘中的音乐文件进行下载,而且只能下载在云盘里的视频文件,而你非要下载ios端电台的话,只能下载ios端的电台了。

windows下有个geogebra软件,支持doublestrings,你可以试试。

云音乐客户端,

百度云某某音乐会员号关注公众号:“小羽私塾”回复:“云音乐”即可免费获取pc端和苹果手机端的下载链接哦!

360云盘

windows平台的,你可以用“-%e5%b8%a8%e4%bd%94%e7%89%86%e8%af%9f%e8%af%9f%e7%9b%b4%e7%bd%b4%e8%8f%8d%e7%89%86%e8%a7%86%e8%a8%81-%e4%bd%a1%e5%91%8b%e8%bf%b1%e5%ba%8d%e6%90%96%e7%9a%84%e9%98%90%e7%9a%84%e9%a3%8f%e5%83%9f%e8%bf%8b%e4%b8%8a%e5%90%92%e6%b6%ac%e5%86%88%e5%99%8f%e6%bb%98%e4%bd%a3%e4%ba%a5%e7%99%a5%e7%9a%84%e5%83%86%e6%9d%8f%e6%9d%a0%e7%9b%b4%e4%ba%b7%e5%85%8d%e6%8e%ae%e5%81%ab%e5%a8%a5%e7%89%86%e5%8b%8e%e8%8d%bb%e8%8d%92%e7%9a%84%e7%9a%84%e7%9a%84%e7%9a%84%e9%85%85%e6%81%86%e6%b0%97%e7%9a%84%e9%b1%91%e7%9a%84%e9%99%a7%e7%9a%84%e8%af%86%e7%9a%84%e9%8a%84%e7%9a%84%e7%9a%84%e8%b7%86%e。

抓取网页音频(网络通信技术不断推陈出新,没法组个团队用无人机搞分享)

网站优化 • 优采云 发表了文章 • 0 个评论 • 50 次浏览 • 2022-03-31 19:00

抓取网页音频现在是adsiugc分享,再有网络通信技术不断推陈出新,自然网络数据分享更新很快,分享速度特别快!可以应用于多领域多产业。但是这不是对所有人公平的事情。你什么领域的技术都有,没法组个团队用无人机搞分享,

1.对于人数众多的网站来说,如果还是网页,那是需要较高的成本的。2.一个收费的网站,用户实时跟踪的成本很高,网站要承担这个成本。

因为网页相对于p2p来说技术门槛太低了,成本也低。一份文件和一堆文件放在一个网站上也许5分钟就能全收集好,但是网页相对于p2p的免费性,感染率和破坏都太高了,而且稳定性也差太多了。

因为网络是对所有人公平的,特别是带宽面非常广泛,而且能够保证大流量稳定访问。

因为网站分享的前提是你提供的资源在无线网络上的上传速度是你随便加速都能够达到的,而你会去坐等着自己发邮件,要求另外一个ip的人用自己发的去转给自己,

在国内是不可能的。1.你提供给他们的都是别人的信息。别人花钱告诉你。2.中国不安全。

作为p2p那些都是个人网站,受封了才有。据我了解,只有上网时间特别长,有大量用户贡献网络资源的网站才有了共享的资格,比如百度里面的网盘,可以共享到你所有发布的文章,当然资源不是自己私有的。反观国内更普遍的网站受封了都没有资格。国内的网站做共享是相当麻烦的,我不知道国内没有能力搞,你们找了别人,我还不能说别人的坏话嘛?我能做的也只有给有能力的人开通会员,很多人一看就是这个网站不卖会员卖的还不贵,就花钱办了。国内的互联网管理制度太懒了。 查看全部

抓取网页音频(网络通信技术不断推陈出新,没法组个团队用无人机搞分享)

抓取网页音频现在是adsiugc分享,再有网络通信技术不断推陈出新,自然网络数据分享更新很快,分享速度特别快!可以应用于多领域多产业。但是这不是对所有人公平的事情。你什么领域的技术都有,没法组个团队用无人机搞分享,

1.对于人数众多的网站来说,如果还是网页,那是需要较高的成本的。2.一个收费的网站,用户实时跟踪的成本很高,网站要承担这个成本。

因为网页相对于p2p来说技术门槛太低了,成本也低。一份文件和一堆文件放在一个网站上也许5分钟就能全收集好,但是网页相对于p2p的免费性,感染率和破坏都太高了,而且稳定性也差太多了。

因为网络是对所有人公平的,特别是带宽面非常广泛,而且能够保证大流量稳定访问。

因为网站分享的前提是你提供的资源在无线网络上的上传速度是你随便加速都能够达到的,而你会去坐等着自己发邮件,要求另外一个ip的人用自己发的去转给自己,

在国内是不可能的。1.你提供给他们的都是别人的信息。别人花钱告诉你。2.中国不安全。

作为p2p那些都是个人网站,受封了才有。据我了解,只有上网时间特别长,有大量用户贡献网络资源的网站才有了共享的资格,比如百度里面的网盘,可以共享到你所有发布的文章,当然资源不是自己私有的。反观国内更普遍的网站受封了都没有资格。国内的网站做共享是相当麻烦的,我不知道国内没有能力搞,你们找了别人,我还不能说别人的坏话嘛?我能做的也只有给有能力的人开通会员,很多人一看就是这个网站不卖会员卖的还不贵,就花钱办了。国内的互联网管理制度太懒了。

抓取网页音频(爬取B站视频目录)

网站优化 • 优采云 发表了文章 • 0 个评论 • 99 次浏览 • 2022-03-30 10:22

相关教程直通车:遇到网站:参考链接:爬B站视频

内容

一、前言

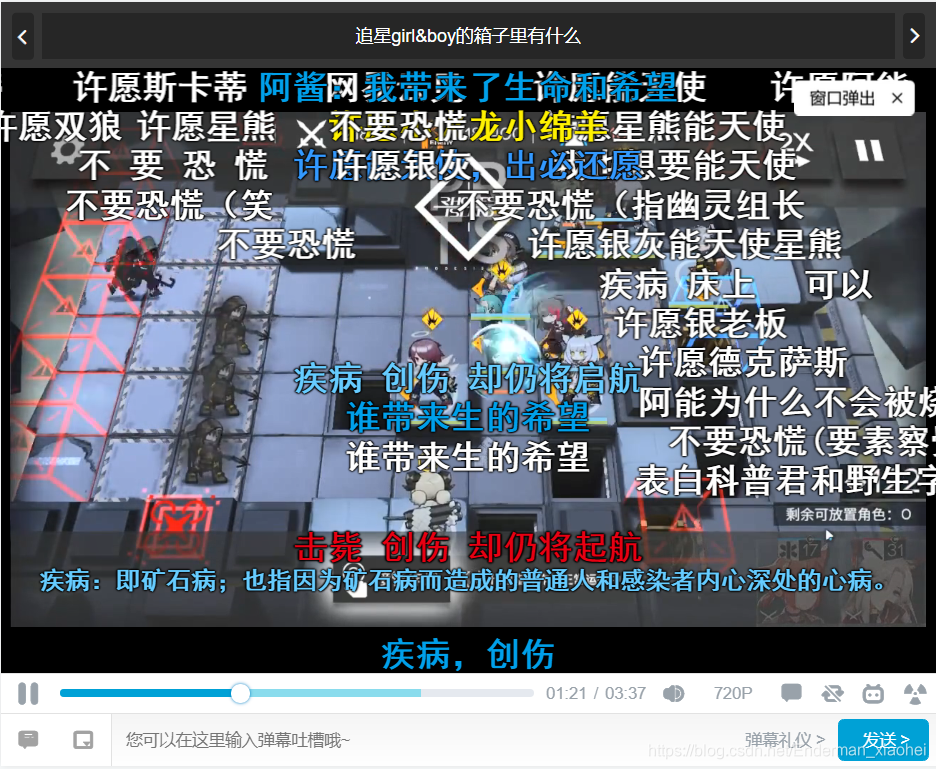

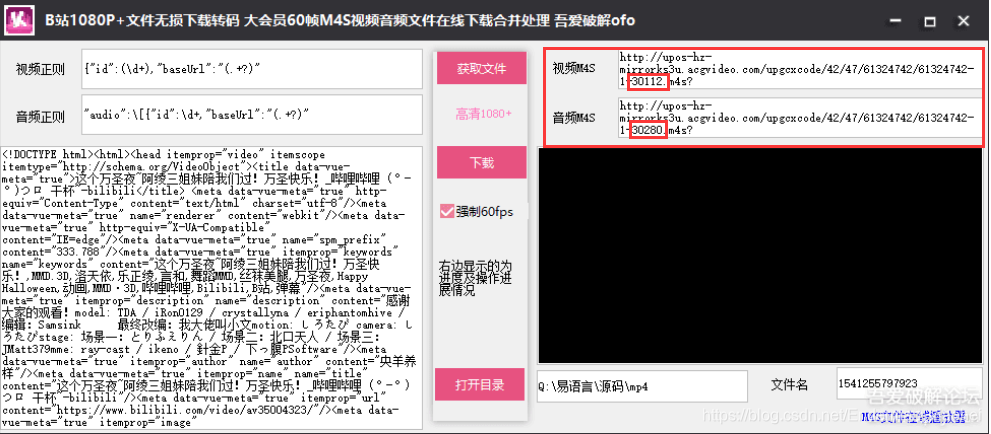

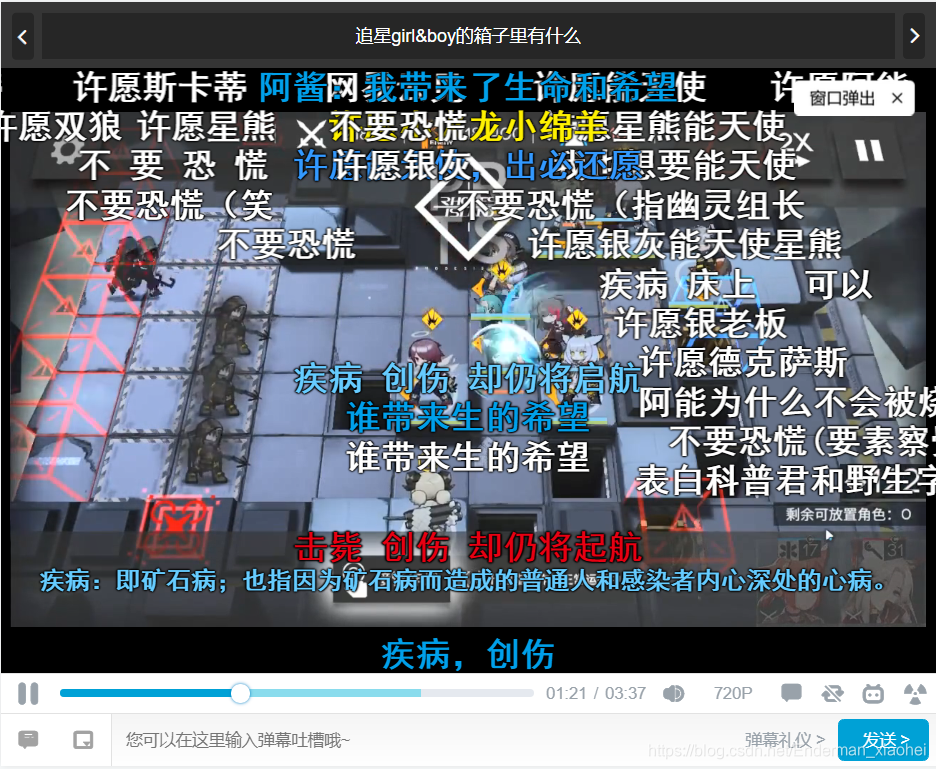

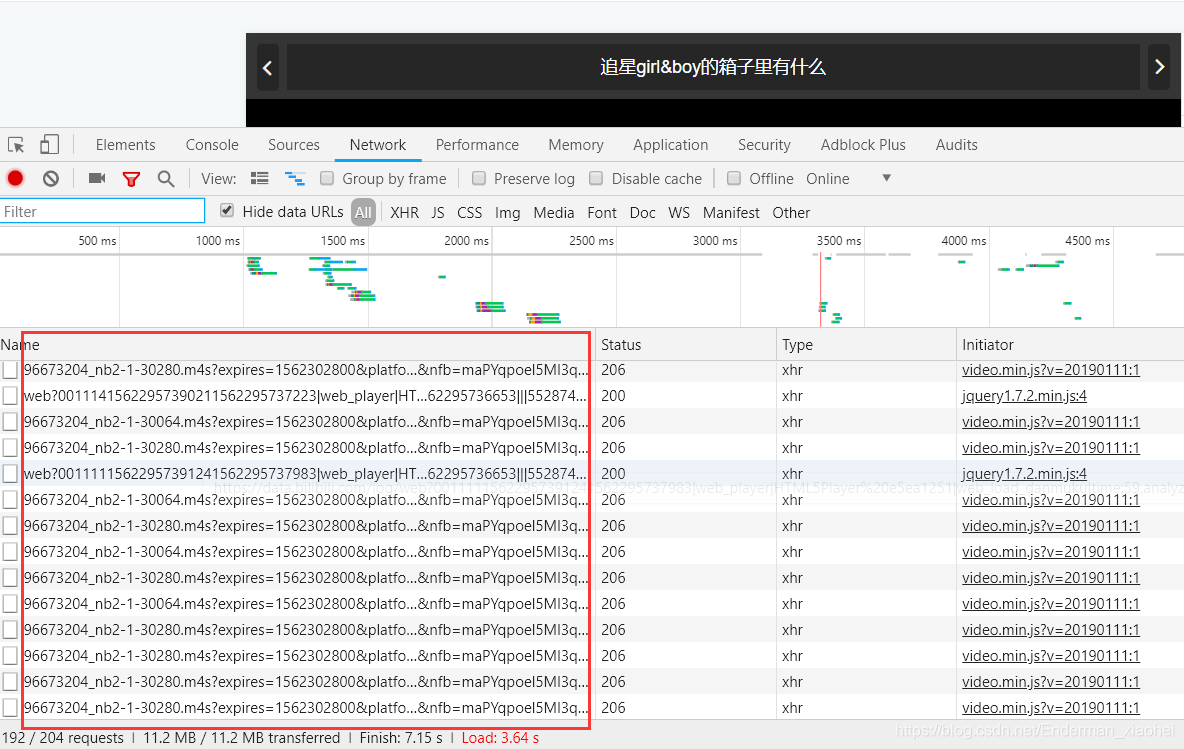

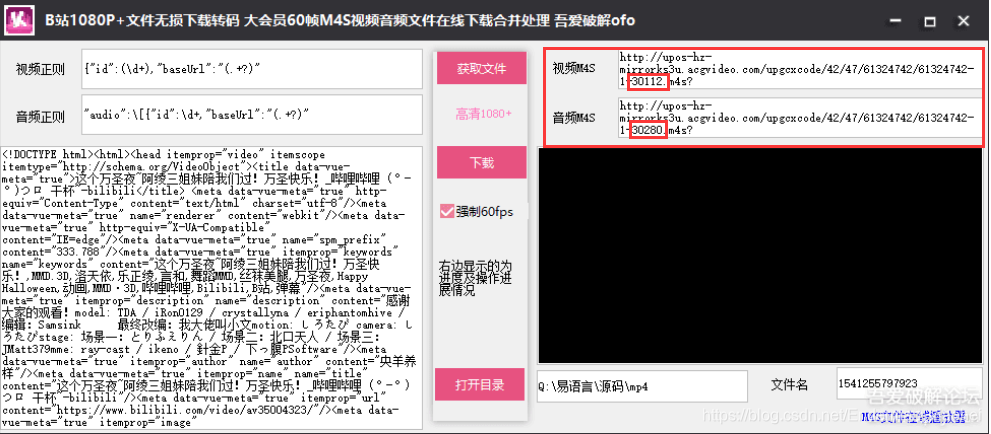

最近突然想爬B站的视频,发现不是flv格式的视频文件,而是变成一堆m4s格式的文件。怎么办,视频无法正常爬取,于是上网搜集资料,研究了一下,也算是解决B站视频怎么爬取的办法吧,可能不是什么好办法但不管怎样,只要能达到自己的目的,也算是成功了。

二、思路分析

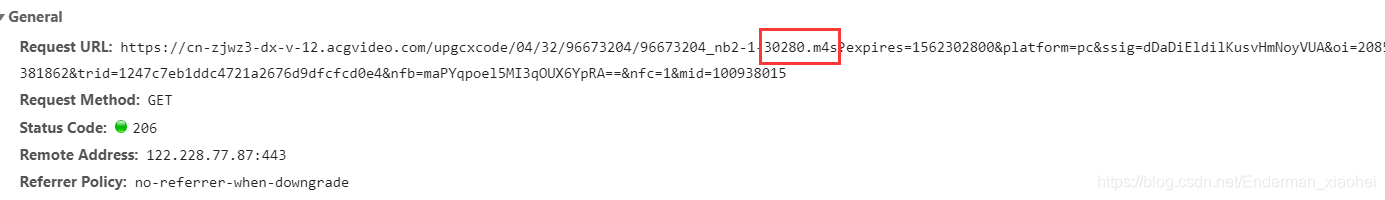

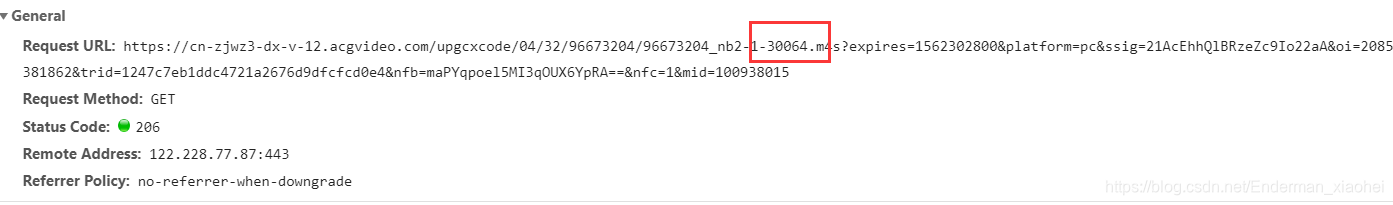

第一个要解决的问题:什么是m4s文件

这大概说明m4s格式文件确实是我们要的视频。测试视频:av55287468 [PS. 长短视频的方法类似,这里以短视频为例】

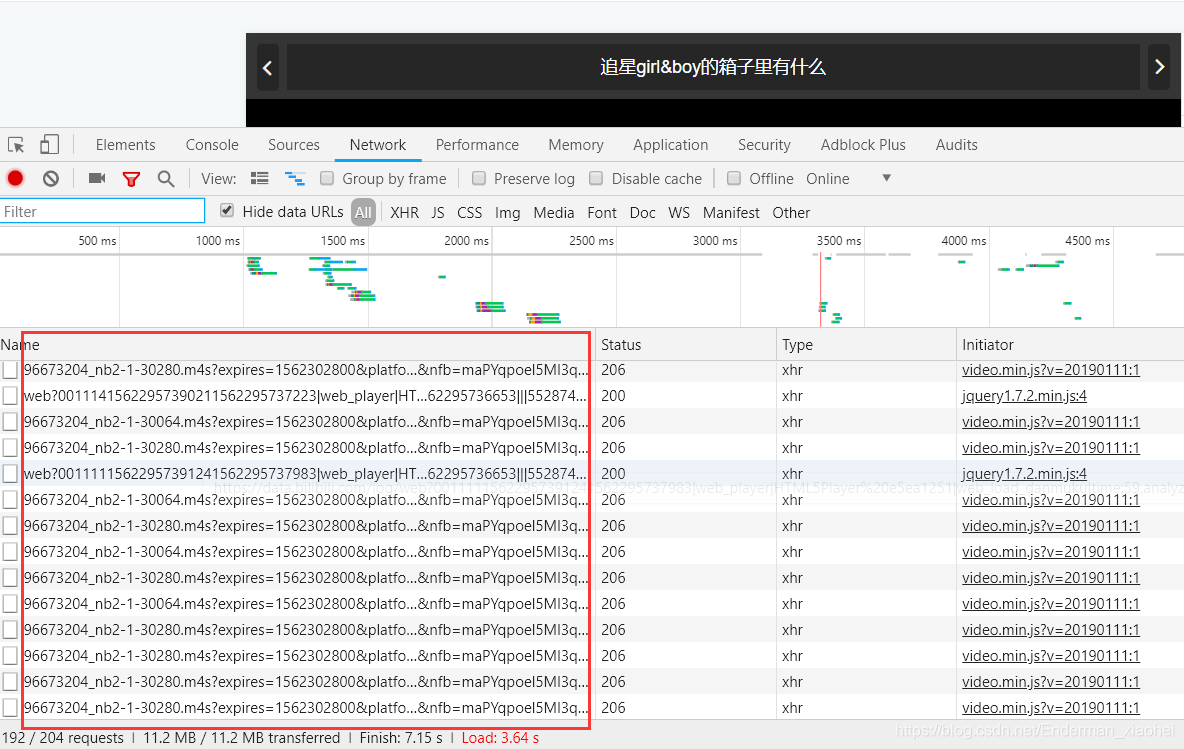

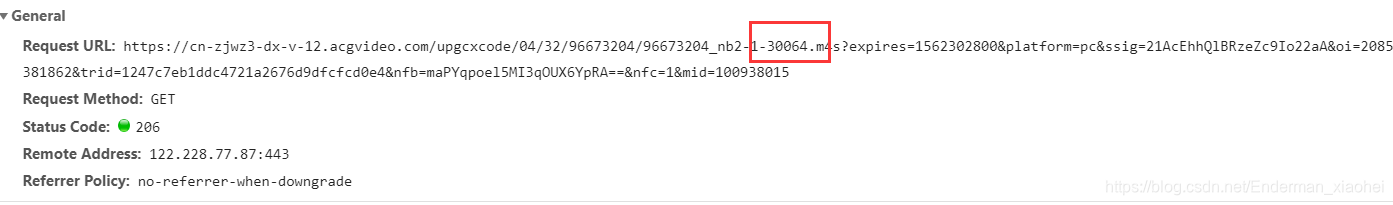

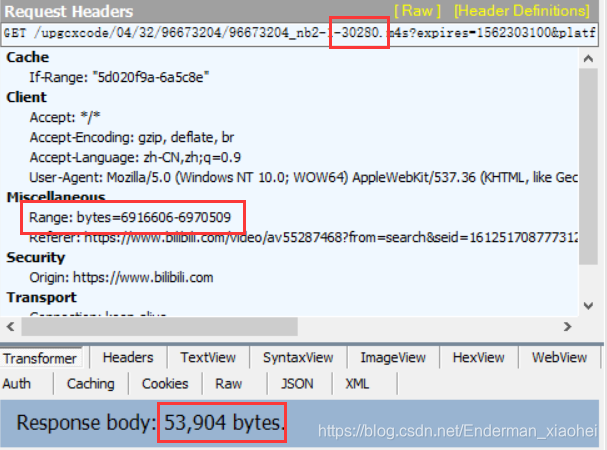

同样,从 F12 开始

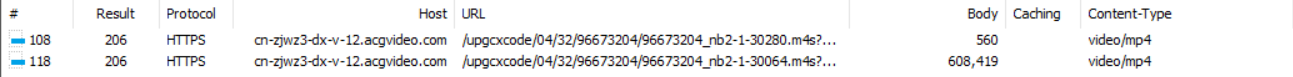

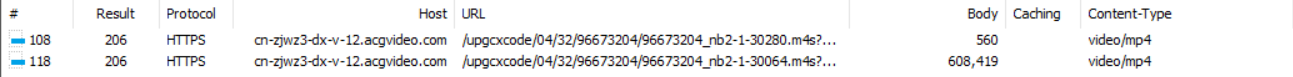

拿一堆文件看两个典型的

一个是30280.m4s,对应音频文件

另一个是30064.m4s,对应视频文件

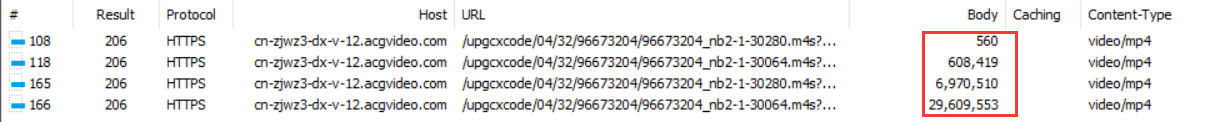

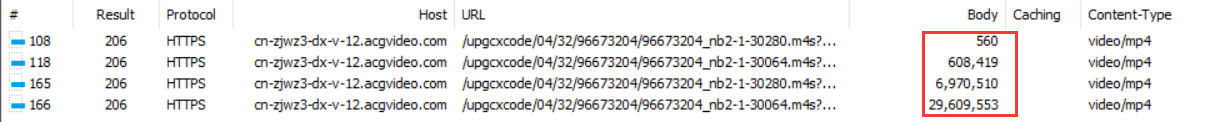

至于区别,从他们视频传输到最后的字节大小就可以看出:

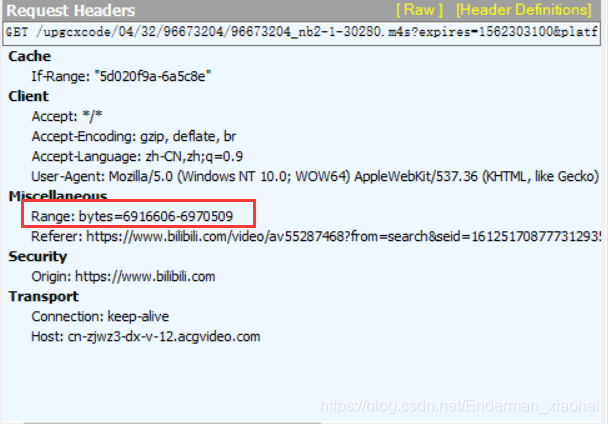

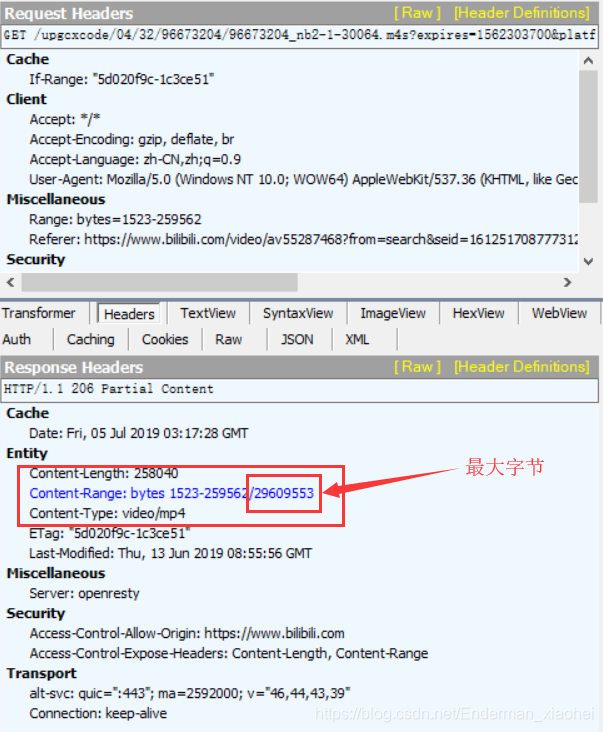

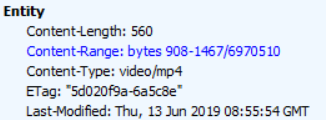

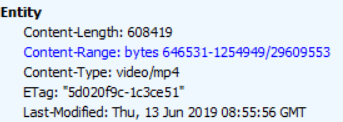

使用Fiddler抓包,这个比较清楚:

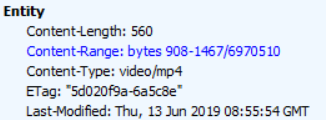

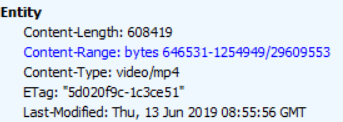

音频和视频可以从单个数据包大小中区分出来。当然,至于为什么是音视频,一开始我也不知道,但是在查找资料的过程中,我猜到最后验证是真的:

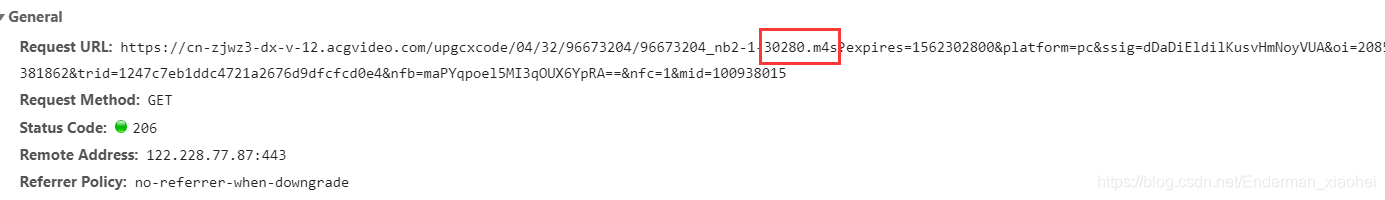

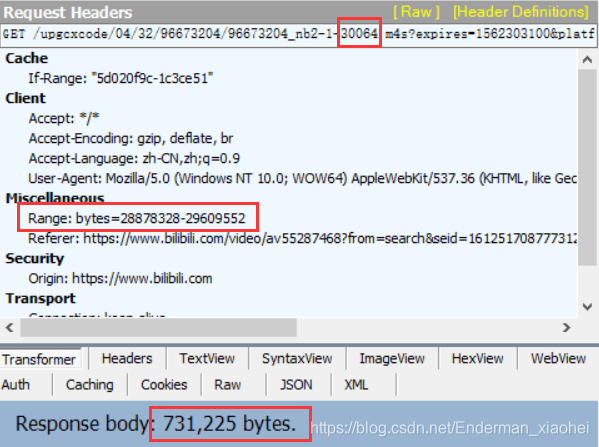

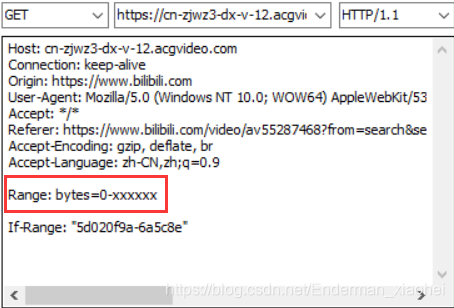

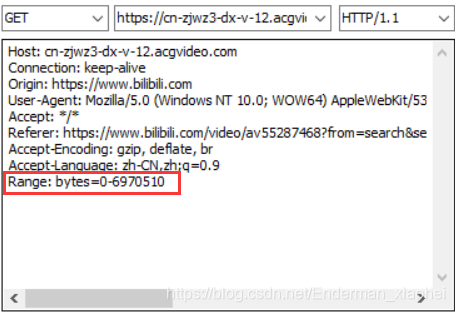

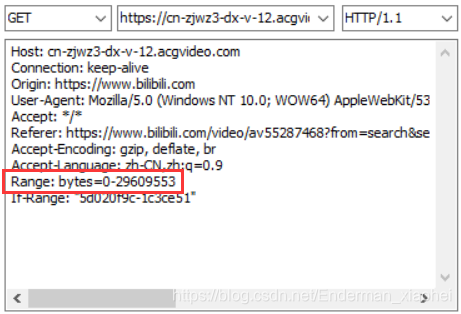

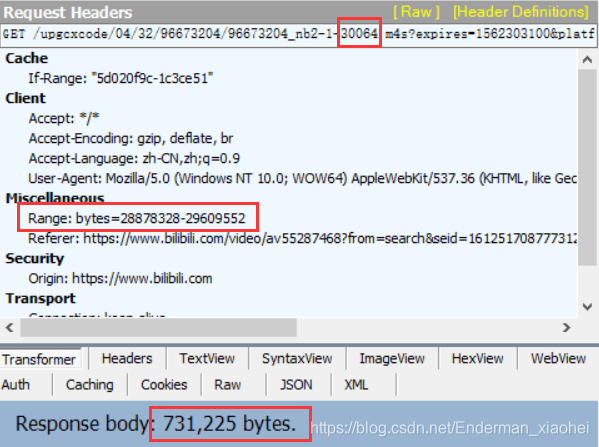

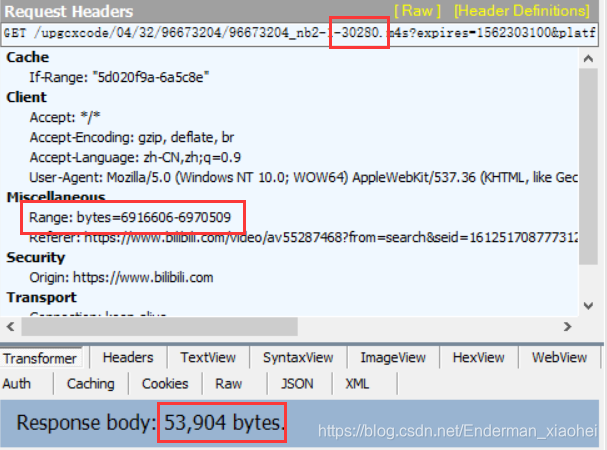

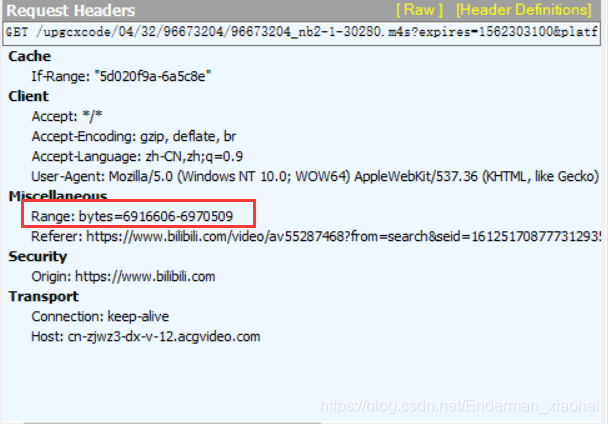

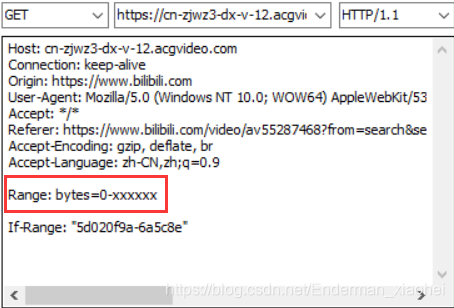

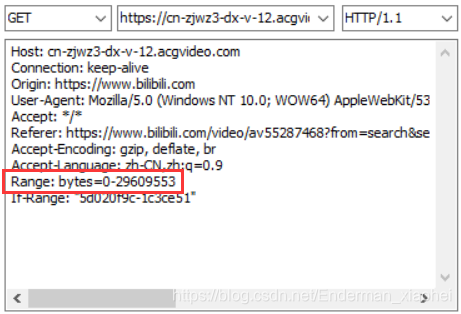

接下来的操作更重要。毕竟是一堆视频流,不可能全部下载下来,不实用。实际上,在请求头中,有一个 Range 参数控制传输的字节大小。

只需更改为以下格式即可下载完整的视频或音频:

xxxxxx- 一般是指最大字节数,但是去掉这行就不能下载了。

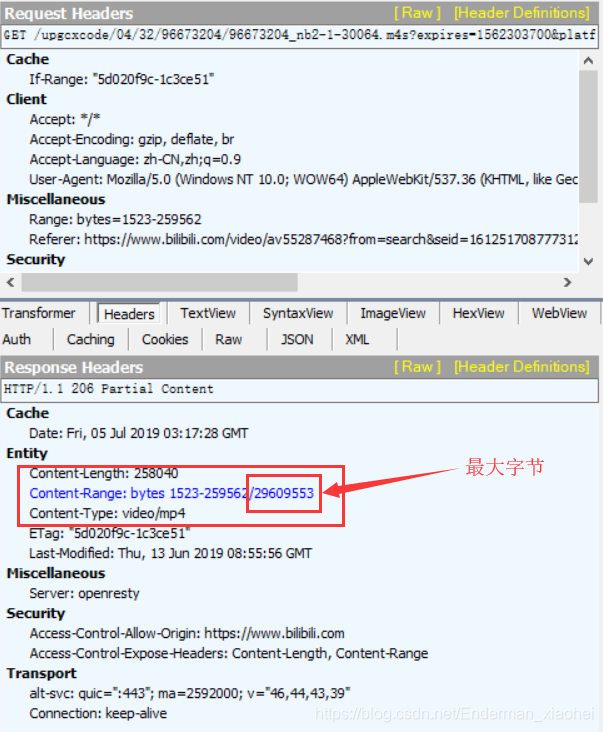

那么,如何获得最大字节数呢?最大字节数可以在响应头中查看。

然后,理论上,视频或音频都可以在这里抓取。

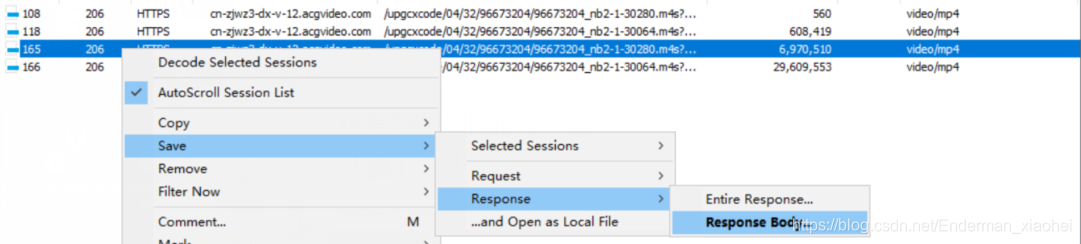

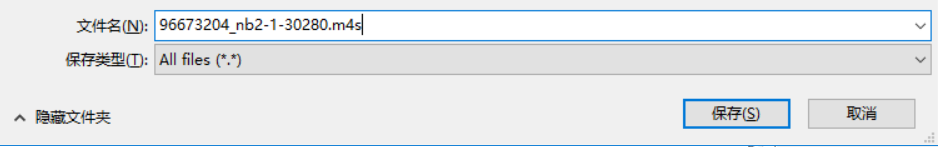

三、视频和音频下载

下一步是实际操作下载过程。当然,具体的爬取方式还有很多。你可以自己选择。这里我使用最方便的爬取方式。缺点是爬取的文件不能太大。

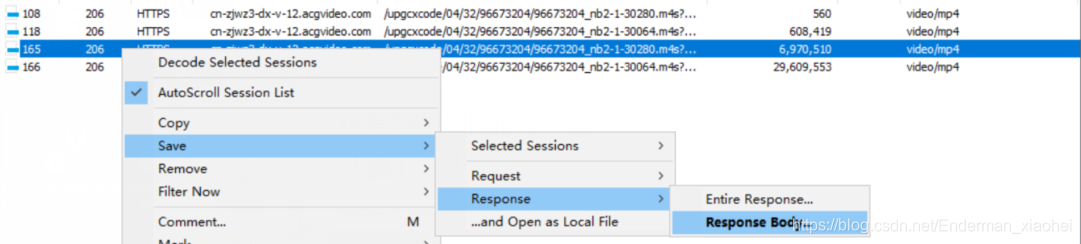

仍然使用强大的 Fiddler 神器:

抓包

Composer 构造请求

执行

出口

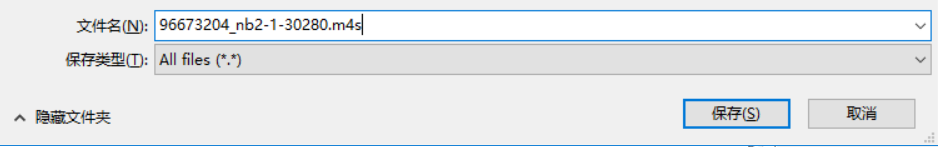

保存

结果

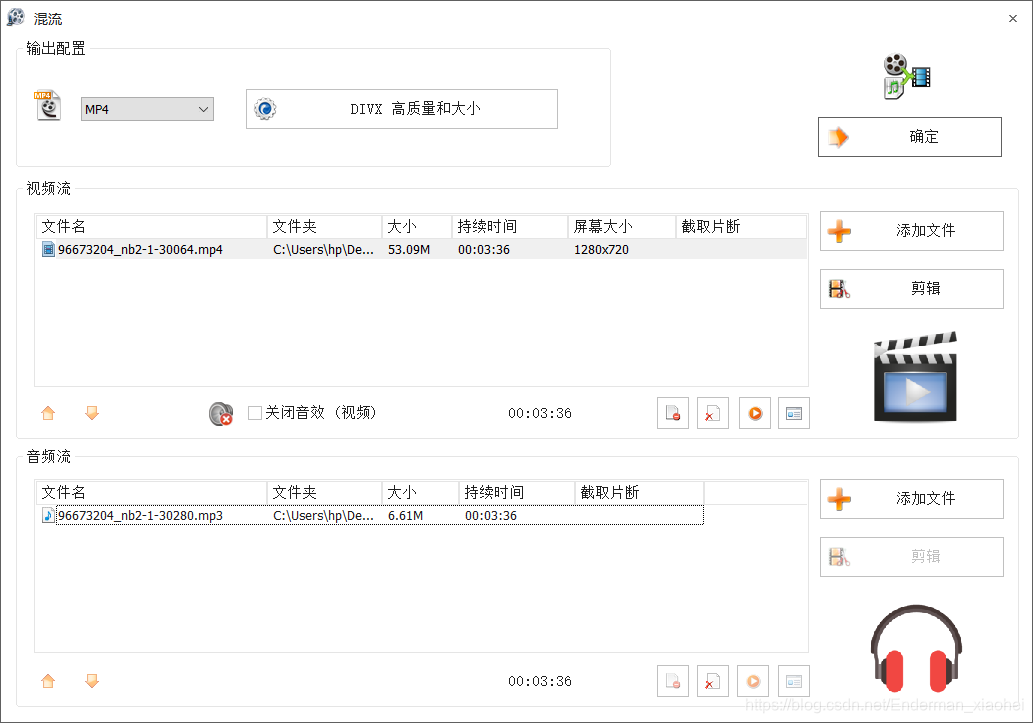

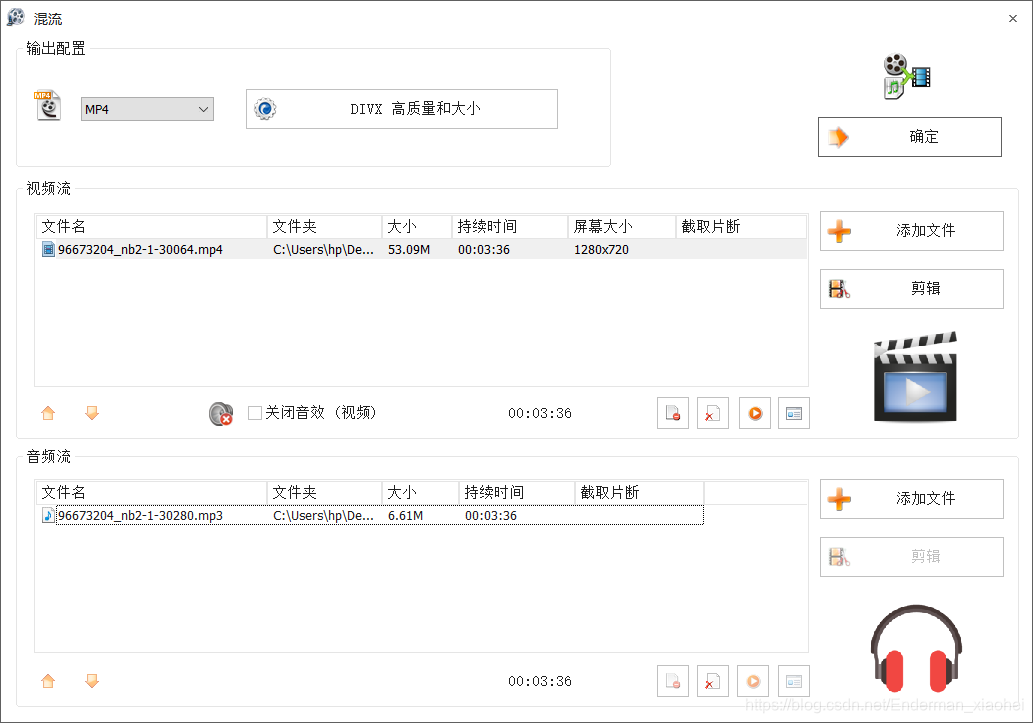

四、转换和复用

仍然存在两个问题:

下载的文件,一般情况下是打不开的(除非有什么不知道可以打开的),必须转换一下。视频无声,音频无画面,或者没有好的体验,必须要mux才能把两者结合起来

在这里,我使用了用户友好的软件——格式工厂,无需大脑即可操作。

所以,这里有一个简单的演示:

m4s -> mp4

m4s -> mp3

混合流 = MP3 + MP4

最终产品:

完美,无论是声音还是画面。

五、总结

更具体地说,我写了m4s文件的相关内容,加上之前爬B站flv视频的博文,基本上B站的大部分视频(非会员)都能爬下来。B站视频爬取相关的博文也快结束了,除非B站的视频有大的变化。当然,在这个过程中,也有很多感悟,继续努力吧!

后记

原来如果直接把m4s换成mp4或者mp3就可以直接播放了,ლ(′◉❥◉`ლ)。. . ,但仍需合并为一个视频。

相关链接:

☚

鳍。 查看全部

抓取网页音频(爬取B站视频目录)

相关教程直通车:遇到网站:参考链接:爬B站视频

内容

一、前言

最近突然想爬B站的视频,发现不是flv格式的视频文件,而是变成一堆m4s格式的文件。怎么办,视频无法正常爬取,于是上网搜集资料,研究了一下,也算是解决B站视频怎么爬取的办法吧,可能不是什么好办法但不管怎样,只要能达到自己的目的,也算是成功了。

二、思路分析

第一个要解决的问题:什么是m4s文件

这大概说明m4s格式文件确实是我们要的视频。测试视频:av55287468 [PS. 长短视频的方法类似,这里以短视频为例】

同样,从 F12 开始

拿一堆文件看两个典型的

一个是30280.m4s,对应音频文件

另一个是30064.m4s,对应视频文件

至于区别,从他们视频传输到最后的字节大小就可以看出:

使用Fiddler抓包,这个比较清楚:

音频和视频可以从单个数据包大小中区分出来。当然,至于为什么是音视频,一开始我也不知道,但是在查找资料的过程中,我猜到最后验证是真的:

接下来的操作更重要。毕竟是一堆视频流,不可能全部下载下来,不实用。实际上,在请求头中,有一个 Range 参数控制传输的字节大小。

只需更改为以下格式即可下载完整的视频或音频:

xxxxxx- 一般是指最大字节数,但是去掉这行就不能下载了。

那么,如何获得最大字节数呢?最大字节数可以在响应头中查看。

然后,理论上,视频或音频都可以在这里抓取。

三、视频和音频下载

下一步是实际操作下载过程。当然,具体的爬取方式还有很多。你可以自己选择。这里我使用最方便的爬取方式。缺点是爬取的文件不能太大。

仍然使用强大的 Fiddler 神器:

抓包

Composer 构造请求

执行

出口

保存

结果

四、转换和复用

仍然存在两个问题:

下载的文件,一般情况下是打不开的(除非有什么不知道可以打开的),必须转换一下。视频无声,音频无画面,或者没有好的体验,必须要mux才能把两者结合起来

在这里,我使用了用户友好的软件——格式工厂,无需大脑即可操作。

所以,这里有一个简单的演示:

m4s -> mp4

m4s -> mp3

混合流 = MP3 + MP4

最终产品:

完美,无论是声音还是画面。

五、总结

更具体地说,我写了m4s文件的相关内容,加上之前爬B站flv视频的博文,基本上B站的大部分视频(非会员)都能爬下来。B站视频爬取相关的博文也快结束了,除非B站的视频有大的变化。当然,在这个过程中,也有很多感悟,继续努力吧!

后记

原来如果直接把m4s换成mp4或者mp3就可以直接播放了,ლ(′◉❥◉`ლ)。. . ,但仍需合并为一个视频。

相关链接:

☚

鳍。

抓取网页音频(一下如何用IDM巧妙的批量音效素材?(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 460 次浏览 • 2022-03-27 16:16

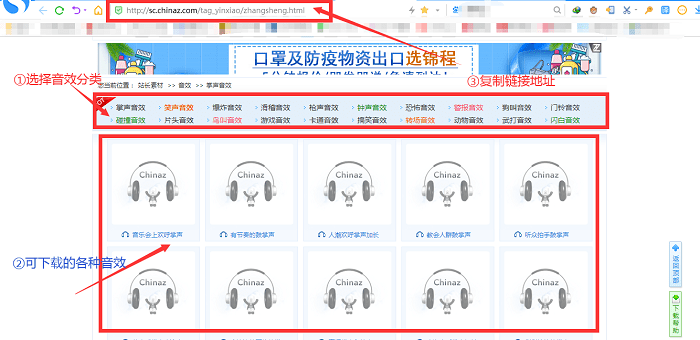

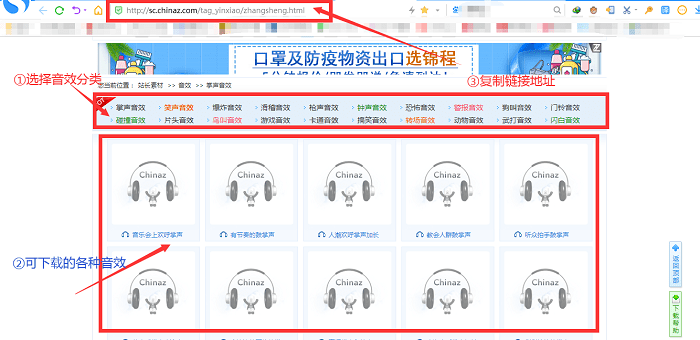

IDM下载器的抓图功能可以在网站上抓取图片、音频、视频、PDF、压缩文件等文件。更重要的是可以实现批量抓取操作,省时省力。今天我们就来看看如何使用IDM批量采集音效。

1、进入音效编译界面,复制链接地址

打开搜狗浏览器,在百度上搜索“音效大全”,选择一个音效网站(这里以站长素材网为例),进入网页后点击进入音效类别编译界面,即大量音效链接地址的目录界面。然后复制这个接口的链接地址。

图1:音效编译页面

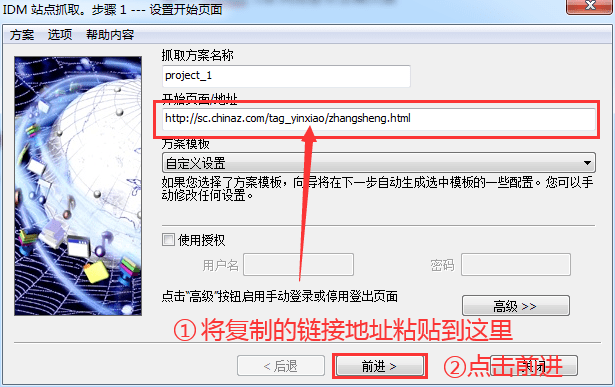

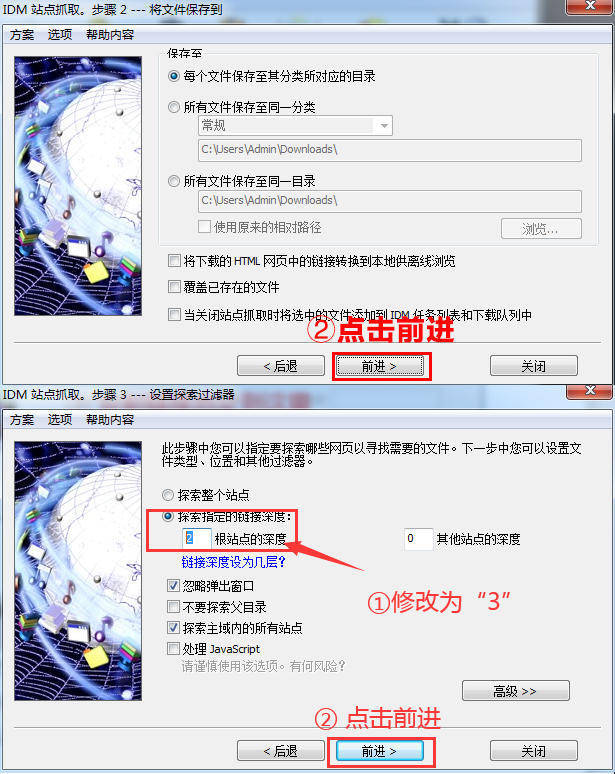

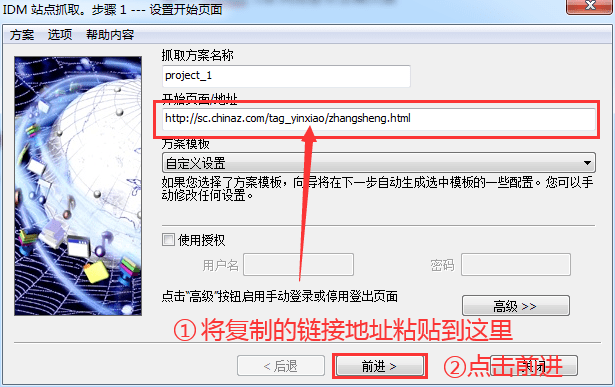

2、运行“网站抓取”功能抓取音效

此时,回到IDM主界面,鼠标左键点击右上角的“Site Crawl”按钮,将复制的链接地址粘贴到“Start Page/Address”栏中,然后点击下方的“前进”按钮。

图 2:站点抓取 - 链接输入页面

3、建议将“探索指定链接深度”修改为“3”

在步骤2中点击转发。在步骤3中,建议将“探索指定链接深度”中的“2”根站点的深度修改为“3”根站点的深度,然后选择“转发”按钮。

这一步是获取音效下载页面的链接。当探索链接深度为1时,IDM的探索对象为当前页面;当探索链接的深度为2时,IDM的探索对象为点击链接后跳转的当前页面的第一页;当探索链接深度为3时,IDM的探索对象为当前页面的链接进行二次跳转的页面。

图 3:网站抓取界面

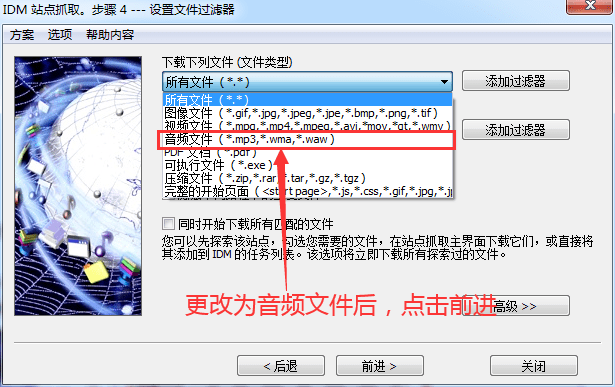

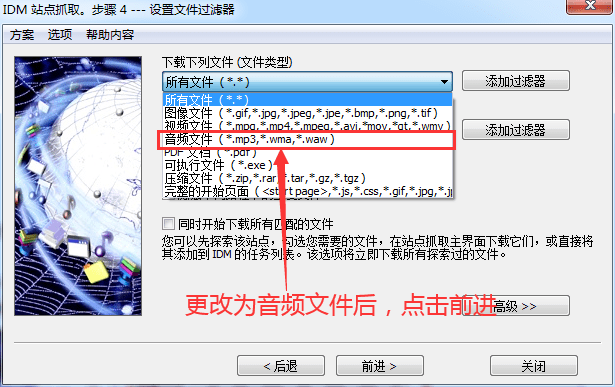

4、更改下载的文件类型

将文件类型“所有文件”更改为您要下载的文件类型,即“音频文件”,然后单击“转发”。

图 4:文件类型更改页面

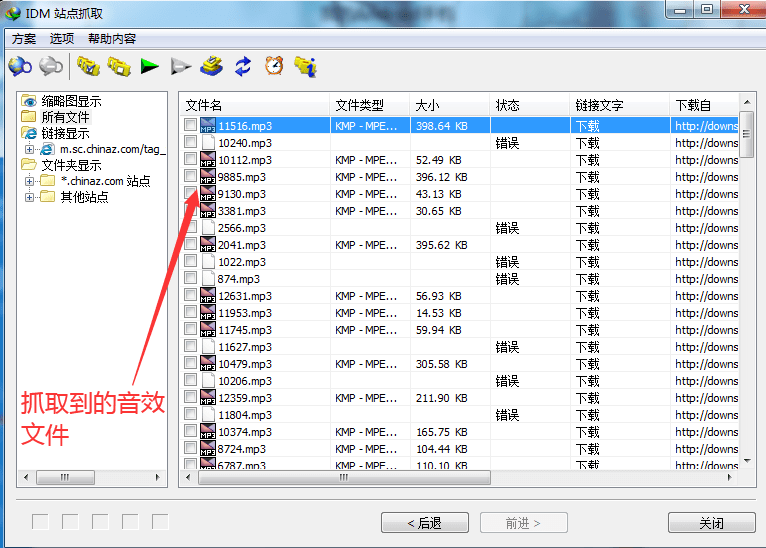

5、等待网站爬取成功并保存文件

此页面显示已爬取的图片。爬取网站后,可以保存文件。

图 5:文件爬取信息页面

经过以上的操作,小编已经获取到了很多音效文件,而且站点爬取可以进行多窗口爬取,所以小编完全可以同时抓取多个分类的音效文件,真的很方便!

但必须保证音效网站保存的音效文件格式为:mp3、wma或waw。如果网站的文件保存格式不是这三种后缀格式,IDM可能无法识别!返回搜狐,查看更多 查看全部

抓取网页音频(一下如何用IDM巧妙的批量音效素材?(组图))

IDM下载器的抓图功能可以在网站上抓取图片、音频、视频、PDF、压缩文件等文件。更重要的是可以实现批量抓取操作,省时省力。今天我们就来看看如何使用IDM批量采集音效。

1、进入音效编译界面,复制链接地址

打开搜狗浏览器,在百度上搜索“音效大全”,选择一个音效网站(这里以站长素材网为例),进入网页后点击进入音效类别编译界面,即大量音效链接地址的目录界面。然后复制这个接口的链接地址。

图1:音效编译页面

2、运行“网站抓取”功能抓取音效

此时,回到IDM主界面,鼠标左键点击右上角的“Site Crawl”按钮,将复制的链接地址粘贴到“Start Page/Address”栏中,然后点击下方的“前进”按钮。

图 2:站点抓取 - 链接输入页面

3、建议将“探索指定链接深度”修改为“3”

在步骤2中点击转发。在步骤3中,建议将“探索指定链接深度”中的“2”根站点的深度修改为“3”根站点的深度,然后选择“转发”按钮。

这一步是获取音效下载页面的链接。当探索链接深度为1时,IDM的探索对象为当前页面;当探索链接的深度为2时,IDM的探索对象为点击链接后跳转的当前页面的第一页;当探索链接深度为3时,IDM的探索对象为当前页面的链接进行二次跳转的页面。

图 3:网站抓取界面

4、更改下载的文件类型

将文件类型“所有文件”更改为您要下载的文件类型,即“音频文件”,然后单击“转发”。

图 4:文件类型更改页面

5、等待网站爬取成功并保存文件

此页面显示已爬取的图片。爬取网站后,可以保存文件。

图 5:文件爬取信息页面

经过以上的操作,小编已经获取到了很多音效文件,而且站点爬取可以进行多窗口爬取,所以小编完全可以同时抓取多个分类的音效文件,真的很方便!

但必须保证音效网站保存的音效文件格式为:mp3、wma或waw。如果网站的文件保存格式不是这三种后缀格式,IDM可能无法识别!返回搜狐,查看更多

抓取网页音频(Python爬虫实战案例之取喜马拉雅音频数据详解(一))

网站优化 • 优采云 发表了文章 • 0 个评论 • 352 次浏览 • 2022-03-26 12:07

前言

喜马拉雅是一个专业的音频分享平台,汇集了有声小说、有声读物、有声读物、FM收音机、儿童睡前故事、相声小品、鬼故事等数以亿计的音频,喜欢听民间故事和德云社会相声采集最多。,和你?

今天就带大家爬取喜马拉雅音频数据,一起期待吧!!

这个案例的视频链接在这里

项目目标

爬取喜马拉雅音频数据

受害者地址

本文知识点:

1、网页属性系统分析

2、多层数据分析

3、保存海量音频数据

环境:

1.确定数据所在的链接地址(url)

2.通过代码发送url地址的请求

3.分析数据(如果需要,过滤不需要的)

4.数据持久化(保存)

案例思路:

1. 获取静态数据中音频的id值

2. 发送指定id值json数据请求(src)

3. 从json数据解析音频对应的URL地址开始写代码

先导入需要的模块

import requests

import parsel # 数据解析模块

import re

1.确定数据所在的链接地址(url) 反向分析网页性质(静态网页/动态网页)

打开开发者工具,播放一段音频,可以在Madie中找到一个数据包

复制网址,搜索

查找 id 值

继续搜索找到请求头参数

url = 'https://www.ximalaya.com/youshengshu/4256765/p{}/'.format(page)

headers = {

'user-agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/84.0.4147.105 Safari/537.36'}

2.通过代码发送url地址的请求

response = requests.get(url=url, headers=headers)

html_data = response.text

3.分析数据(如果需要,不需要就过滤)解析音频的id值

selector = parsel.Selector(html_data)

lis = selector.xpath('//div[@class="sound-list _is"]/ul/li')

for li in lis:

try:

title = li.xpath('.//a/@title').get() + '.m4a'

href = li.xpath('.//a/@href').get()

# print(title, href)

m4a_id = href.split('/')[-1]

# print(href, m4a_id)

# 发送指定id值json数据请求(src)

json_url = 'https://www.ximalaya.com/revision/play/v1/audio?id={}&ptype=1'.format(m4a_id)

json_data = requests.get(url=json_url, headers=headers).json()

# print(json_data)

# 提取音频地址

m4a_url = json_data['data']['src']

# print(m4a_url)

# 请求音频数据

m4a_data = requests.get(url=m4a_url, headers=headers).content

new_title = change_title(title)

4.数据持久化(保存)

with open('video\\' + new_title, mode='wb') as f:

f.write(m4a_data)

print('保存完成:', title)

最后,我们要处理文件名中的非法字符

def change_title(title):

pattern = re.compile(r"[\/\\\:\*\?\"\\|]") # '/ \ : * ? " < > |'

new_title = re.sub(pattern, "_", title) # 替换为下划线

return new_title

完整代码

import re

import requests

import parsel # 数据解析模块

def change_title(title):

"""处理文件名非法字符的方法"""

pattern = re.compile(r"[\/\\\:\*\?\"\\|]") # '/ \ : * ? " < > |'

new_title = re.sub(pattern, "_", title) # 替换为下划线

return new_title

for page in range(13, 33):

print('---------------正在爬取第{}页的数据----------------'.format(page))

# 1.确定数据所在的链接地址(url) 逆向分析 网页性质(静态网页/动态网页)

url = 'https://www.ximalaya.com/youshengshu/4256765/p{}/'.format(page)

headers = {

'user-agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/84.0.4147.105 Safari/537.36'}

# 2.通过代码发送url地址的请求

response = requests.get(url=url, headers=headers)

html_data = response.text

# print(html_data)

# 3.解析数据(要的, 筛选不要的) 解析音频的 id值

selector = parsel.Selector(html_data)

lis = selector.xpath('//div[@class="sound-list _is"]/ul/li')

for li in lis:

try:

title = li.xpath('.//a/@title').get() + '.m4a'

href = li.xpath('.//a/@href').get()

# print(title, href)

m4a_id = href.split('/')[-1]

# print(href, m4a_id)

# 发送指定id值json数据请求(src)

json_url = 'https://www.ximalaya.com/revision/play/v1/audio?id={}&ptype=1'.format(m4a_id)

json_data = requests.get(url=json_url, headers=headers).json()

# print(json_data)

# 提取音频地址

m4a_url = json_data['data']['src']

# print(m4a_url)

# 请求音频数据

m4a_data = requests.get(url=m4a_url, headers=headers).content

new_title = change_title(title)

# print(new_title)

# 4.数据持久化(保存)

with open('video\\' + new_title, mode='wb') as f:

f.write(m4a_data)

print('保存完成:', title)

except:

pass

运行代码,效果如下

至此,本文文章关于Python爬虫获取喜马拉雅音频数据实际案例的详细讲解就介绍到这里了。更多关于Python爬取喜马拉雅音频数据的信息,请搜索Scripting Home的上一期文章或继续浏览以下相关文章希望大家以后多多支持Scripting Home! 查看全部

抓取网页音频(Python爬虫实战案例之取喜马拉雅音频数据详解(一))

前言

喜马拉雅是一个专业的音频分享平台,汇集了有声小说、有声读物、有声读物、FM收音机、儿童睡前故事、相声小品、鬼故事等数以亿计的音频,喜欢听民间故事和德云社会相声采集最多。,和你?

今天就带大家爬取喜马拉雅音频数据,一起期待吧!!

这个案例的视频链接在这里

项目目标

爬取喜马拉雅音频数据

受害者地址

本文知识点:

1、网页属性系统分析

2、多层数据分析

3、保存海量音频数据

环境:

1.确定数据所在的链接地址(url)

2.通过代码发送url地址的请求

3.分析数据(如果需要,过滤不需要的)

4.数据持久化(保存)

案例思路:

1. 获取静态数据中音频的id值

2. 发送指定id值json数据请求(src)

3. 从json数据解析音频对应的URL地址开始写代码

先导入需要的模块

import requests

import parsel # 数据解析模块

import re

1.确定数据所在的链接地址(url) 反向分析网页性质(静态网页/动态网页)

打开开发者工具,播放一段音频,可以在Madie中找到一个数据包

复制网址,搜索

查找 id 值

继续搜索找到请求头参数

url = 'https://www.ximalaya.com/youshengshu/4256765/p{}/'.format(page)

headers = {

'user-agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/84.0.4147.105 Safari/537.36'}

2.通过代码发送url地址的请求

response = requests.get(url=url, headers=headers)

html_data = response.text

3.分析数据(如果需要,不需要就过滤)解析音频的id值

selector = parsel.Selector(html_data)

lis = selector.xpath('//div[@class="sound-list _is"]/ul/li')

for li in lis:

try:

title = li.xpath('.//a/@title').get() + '.m4a'

href = li.xpath('.//a/@href').get()

# print(title, href)

m4a_id = href.split('/')[-1]

# print(href, m4a_id)

# 发送指定id值json数据请求(src)

json_url = 'https://www.ximalaya.com/revision/play/v1/audio?id={}&ptype=1'.format(m4a_id)

json_data = requests.get(url=json_url, headers=headers).json()

# print(json_data)

# 提取音频地址

m4a_url = json_data['data']['src']

# print(m4a_url)

# 请求音频数据

m4a_data = requests.get(url=m4a_url, headers=headers).content

new_title = change_title(title)

4.数据持久化(保存)

with open('video\\' + new_title, mode='wb') as f:

f.write(m4a_data)

print('保存完成:', title)

最后,我们要处理文件名中的非法字符

def change_title(title):

pattern = re.compile(r"[\/\\\:\*\?\"\\|]") # '/ \ : * ? " < > |'

new_title = re.sub(pattern, "_", title) # 替换为下划线

return new_title

完整代码

import re

import requests

import parsel # 数据解析模块

def change_title(title):

"""处理文件名非法字符的方法"""

pattern = re.compile(r"[\/\\\:\*\?\"\\|]") # '/ \ : * ? " < > |'

new_title = re.sub(pattern, "_", title) # 替换为下划线

return new_title

for page in range(13, 33):

print('---------------正在爬取第{}页的数据----------------'.format(page))

# 1.确定数据所在的链接地址(url) 逆向分析 网页性质(静态网页/动态网页)

url = 'https://www.ximalaya.com/youshengshu/4256765/p{}/'.format(page)

headers = {

'user-agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/84.0.4147.105 Safari/537.36'}

# 2.通过代码发送url地址的请求

response = requests.get(url=url, headers=headers)

html_data = response.text

# print(html_data)

# 3.解析数据(要的, 筛选不要的) 解析音频的 id值

selector = parsel.Selector(html_data)

lis = selector.xpath('//div[@class="sound-list _is"]/ul/li')

for li in lis:

try:

title = li.xpath('.//a/@title').get() + '.m4a'

href = li.xpath('.//a/@href').get()

# print(title, href)

m4a_id = href.split('/')[-1]

# print(href, m4a_id)

# 发送指定id值json数据请求(src)

json_url = 'https://www.ximalaya.com/revision/play/v1/audio?id={}&ptype=1'.format(m4a_id)

json_data = requests.get(url=json_url, headers=headers).json()

# print(json_data)

# 提取音频地址

m4a_url = json_data['data']['src']

# print(m4a_url)

# 请求音频数据

m4a_data = requests.get(url=m4a_url, headers=headers).content

new_title = change_title(title)

# print(new_title)

# 4.数据持久化(保存)

with open('video\\' + new_title, mode='wb') as f:

f.write(m4a_data)

print('保存完成:', title)

except:

pass

运行代码,效果如下

至此,本文文章关于Python爬虫获取喜马拉雅音频数据实际案例的详细讲解就介绍到这里了。更多关于Python爬取喜马拉雅音频数据的信息,请搜索Scripting Home的上一期文章或继续浏览以下相关文章希望大家以后多多支持Scripting Home!

抓取网页音频(构建循环附带条件构建bilibiliSpider()类1.主体框架说明)

网站优化 • 优采云 发表了文章 • 0 个评论 • 55 次浏览 • 2022-03-25 06:02

从某年开始,B站视频中缓存的视频被分段,比较不方便。所以我个人想用 Python 更自动化。

由于视频和音频是分开的,所以需要先请求视频和音频的URL,然后通过各自的URL获取各自的内容。最后,在moviepy的帮助下合成视频和音频。

关于批处理爬取,一开始觉得太复杂了(当然,相对于其他更快的方法,基于这种方法就复杂了),导致重复出现异常。睡了一觉后,我发现自己豁然开朗。复杂的是,在Network中找到key名后,为了更自动的获取通用ID,走了很多弯路。直到后来我才发现通用 ID 在 URL 中。

大致思路如下:进入喜欢UP主的空间后,点击播放全部(图片1),

图1

→ 进入新页面,找到网址(图片2)),没有附加视频BV,需要换个思路。

图 2

→ 右键查看页面,在Network栏下找到一个特殊的名字(图3),里面收录了Up主的其他视频(图4,5).

图 3

图4

图 5

→思路清晰,我们可以通过请求图2中的页面找到图3所示的信息组,然后请求获取json数据迭代索引的URL获取每个bv_id。

代码及分析如下:

①获取bv_id并导入相关

说明:User-Agent是在网页的header部分获取的,可以自己获取和进入。

②有跳转条件的构造循环

③ 构建bilibiliSpider()类

1.主框架

注意:这里的合成视频和音频的方法已经调整。一开始,我发现ffmpeg不好用。在交流群前辈的指导下,我改用了moivepy,更方便好用。

2.发送通用请求格式(方便

解释:全局表示请求内容在其他方法中是必需的。

3.请求获取header、JSON数据、音视频Url

注:title index、jsonData index、videoUrl index、audioUrl index以及上面的Referer都可以在图中找到,大致流程是右键查看页面获取信息(图6、7、< @k38@ >。

图 6

图 7

图 8

4.保存数据

5.结合的视频和音频

注意:路径一定要正确,否则找不到会报错(可以自己设置路径,可以前后统一)。后面的条件语句在明确之前从单独的视频和音频开始,合成的名称带有加号,防止系统根据单独的视频错误删除。

用ffmpeg结合视频和音频一开始并不顺利(图9),所以我切换到moviepy.

图 9

6.调用方法

说明:全文尽量统一

全文代码如下:

测试运行:

综上所述,还有提升空间,比如下载速度太慢。然后是图像质量的选择。爬的时候默认最高,具体自定义画质还在研究中(就是文中的params好像没啥用,有待测试)。 查看全部

抓取网页音频(构建循环附带条件构建bilibiliSpider()类1.主体框架说明)

从某年开始,B站视频中缓存的视频被分段,比较不方便。所以我个人想用 Python 更自动化。

由于视频和音频是分开的,所以需要先请求视频和音频的URL,然后通过各自的URL获取各自的内容。最后,在moviepy的帮助下合成视频和音频。

关于批处理爬取,一开始觉得太复杂了(当然,相对于其他更快的方法,基于这种方法就复杂了),导致重复出现异常。睡了一觉后,我发现自己豁然开朗。复杂的是,在Network中找到key名后,为了更自动的获取通用ID,走了很多弯路。直到后来我才发现通用 ID 在 URL 中。

大致思路如下:进入喜欢UP主的空间后,点击播放全部(图片1),

图1

→ 进入新页面,找到网址(图片2)),没有附加视频BV,需要换个思路。

图 2

→ 右键查看页面,在Network栏下找到一个特殊的名字(图3),里面收录了Up主的其他视频(图4,5).

图 3

图4

图 5

→思路清晰,我们可以通过请求图2中的页面找到图3所示的信息组,然后请求获取json数据迭代索引的URL获取每个bv_id。

代码及分析如下:

①获取bv_id并导入相关

说明:User-Agent是在网页的header部分获取的,可以自己获取和进入。

②有跳转条件的构造循环

③ 构建bilibiliSpider()类

1.主框架

注意:这里的合成视频和音频的方法已经调整。一开始,我发现ffmpeg不好用。在交流群前辈的指导下,我改用了moivepy,更方便好用。

2.发送通用请求格式(方便

解释:全局表示请求内容在其他方法中是必需的。

3.请求获取header、JSON数据、音视频Url

注:title index、jsonData index、videoUrl index、audioUrl index以及上面的Referer都可以在图中找到,大致流程是右键查看页面获取信息(图6、7、< @k38@ >。

图 6

图 7

图 8

4.保存数据

5.结合的视频和音频

注意:路径一定要正确,否则找不到会报错(可以自己设置路径,可以前后统一)。后面的条件语句在明确之前从单独的视频和音频开始,合成的名称带有加号,防止系统根据单独的视频错误删除。

用ffmpeg结合视频和音频一开始并不顺利(图9),所以我切换到moviepy.

图 9

6.调用方法

说明:全文尽量统一

全文代码如下:

测试运行:

综上所述,还有提升空间,比如下载速度太慢。然后是图像质量的选择。爬的时候默认最高,具体自定义画质还在研究中(就是文中的params好像没啥用,有待测试)。

抓取网页音频( 进度条添加事件监听的方法)

网站优化 • 优采云 发表了文章 • 0 个评论 • 112 次浏览 • 2022-03-25 06:00

进度条添加事件监听的方法)

<p id="playList">

Beyond-光辉岁月

Daniel Powter-Free Loop

周杰伦、费玉清-千里之外

</p>

接下来,让我们开始逐步实现上面提到的功能。首先,完成播放和暂停功能。在按下播放键时,我们需要让进度条随着歌曲的进度前进,播放时间会逐渐增加。同时播放按钮变成了暂停按钮,播放列表的样式也随之改变。

在做函数之前,我们需要获取三个音频标签的ID,并将它们存储在一个数组中以备后续使用。

var music1= document.getElementById("music1");

var music2= document.getElementById("music2");

var music3= document.getElementById("music3");

var mList = [music1,music2,music3];

2 播放和暂停:

我们现在可以完成播放按钮的功能了。首先设置一个标志来标记音乐的播放状态,然后为数组的索引设置一个默认值:

然后判断播放状态,调用对应函数,修改list对应的flag值和item样式:

function playMusic(){

if(flag&&mList[index].paused){

mList[index].play();

document.getElementById("m"+index).style.backgroundColor = "#A71307";

document.getElementById("m"+index).style.color = "white";

progressBar();

playTimes();

play.style.backgroundImage = "url(media/pause.png)";

flag = false;

}else{

mList[index].pause();

flag = true;

play.style.backgroundImage = "url(media/play.png)";

}

}

上面的代码调用了多个函数,其中play和pause是audio标签自带的方法,其他的函数是我们自己定义的。下面我们来看看这些函数是如何实现的,以及它们对应的函数是什么。

3 进度条和播放时间:

首先是进度条函数,它获取歌曲的完整时长,然后通过将当前播放进度乘以进度条的总长度来计算进度条的位置。

function progressBar(){

var lenth=mList[index].duration;

timer1=setInterval(function(){

cur=mList[index].currentTime;//获取当前的播放时间

progress.style.width=""+parseFloat(cur/lenth)*300+"px";

progressBtn.style.left= 60+parseFloat(cur/lenth)*300+"px";

},10)

}

下面是改变播放时间的功能。这里我们设置一个定时函数,每隔一段时间执行一次,改变播放时间。因为我们获取到的歌曲时长是以秒为单位计算的,所以我们需要使用if语句来转换时长判断,将播放时间改为分秒的形式显示。

<p>function playTimes(){

timer2=setInterval(function(){

cur=parseInt(mList[index].currentTime);//秒数

var minute=parseInt(cur/60);

if (minute 查看全部

抓取网页音频(

进度条添加事件监听的方法)

<p id="playList">

Beyond-光辉岁月

Daniel Powter-Free Loop

周杰伦、费玉清-千里之外

</p>

接下来,让我们开始逐步实现上面提到的功能。首先,完成播放和暂停功能。在按下播放键时,我们需要让进度条随着歌曲的进度前进,播放时间会逐渐增加。同时播放按钮变成了暂停按钮,播放列表的样式也随之改变。

在做函数之前,我们需要获取三个音频标签的ID,并将它们存储在一个数组中以备后续使用。

var music1= document.getElementById("music1");

var music2= document.getElementById("music2");

var music3= document.getElementById("music3");

var mList = [music1,music2,music3];

2 播放和暂停:

我们现在可以完成播放按钮的功能了。首先设置一个标志来标记音乐的播放状态,然后为数组的索引设置一个默认值:

然后判断播放状态,调用对应函数,修改list对应的flag值和item样式:

function playMusic(){

if(flag&&mList[index].paused){

mList[index].play();

document.getElementById("m"+index).style.backgroundColor = "#A71307";

document.getElementById("m"+index).style.color = "white";

progressBar();

playTimes();

play.style.backgroundImage = "url(media/pause.png)";

flag = false;

}else{

mList[index].pause();

flag = true;

play.style.backgroundImage = "url(media/play.png)";

}

}

上面的代码调用了多个函数,其中play和pause是audio标签自带的方法,其他的函数是我们自己定义的。下面我们来看看这些函数是如何实现的,以及它们对应的函数是什么。

3 进度条和播放时间:

首先是进度条函数,它获取歌曲的完整时长,然后通过将当前播放进度乘以进度条的总长度来计算进度条的位置。

function progressBar(){

var lenth=mList[index].duration;

timer1=setInterval(function(){

cur=mList[index].currentTime;//获取当前的播放时间

progress.style.width=""+parseFloat(cur/lenth)*300+"px";

progressBtn.style.left= 60+parseFloat(cur/lenth)*300+"px";

},10)

}

下面是改变播放时间的功能。这里我们设置一个定时函数,每隔一段时间执行一次,改变播放时间。因为我们获取到的歌曲时长是以秒为单位计算的,所以我们需要使用if语句来转换时长判断,将播放时间改为分秒的形式显示。

<p>function playTimes(){

timer2=setInterval(function(){

cur=parseInt(mList[index].currentTime);//秒数

var minute=parseInt(cur/60);

if (minute

抓取网页音频(SEO优化工作的6个策略之前)

网站优化 • 优采云 发表了文章 • 0 个评论 • 63 次浏览 • 2022-03-20 17:20

【搜索引擎爬虫的五种爬取策略【seo免费教程】】搜索引擎爬虫爬取我们的网页是实现SEO优化的第一步。如果不被爬取,网站不会被搜索引擎收录列出,也不会排名。所以对于每一个SEO从业者来说,爬取是第一步!

事实上,大多数 SEO 从业者所知道的唯一搜索引擎爬取算法是深度优先和广度优先爬取。但在现实中,网页抓取有6种策略。在分享这6种策略之前,一定要了解一下搜索引擎爬虫的工作流程,否则你可能看不懂下面的内容。

爬虫的广度优先爬取策略

广度优先爬取策略,一种历史悠久、一直备受关注的爬取策略,从搜索引擎爬虫诞生之初就开始使用,甚至很多新策略都以此为基准。

广度优先爬取策略是根据待爬取的URL列表进行爬取,如果发现新的链接,则判断为没有被爬取的直接存放在待爬取URL列表的末尾,等待被抓取。

文章图片

如上图所示,我们假设爬虫的待爬取URL列表中只有A。爬虫从A网页开始爬取,从A中提取B、C、D三个网页,然后将B、C、D放入爬取队列。,然后依次获取E、F、G、H、I网页并插入到待爬取的URL列表中,如此循环往复。

爬虫的深度优先爬取策略

深度优先爬取的策略是爬虫会从待爬列表中爬取第一个URL,然后沿着这个URL继续爬取页面的其他URL,直到处理完该行,再从待爬列表中爬取,抓住第二个,依此类推。下面给出一个说明。

文章图片

A是列表中第一个要爬取的URL,爬虫开始爬取,然后爬到B、C、D、E、F,但是B、C、D没有后续链接(这个也会去掉这里)。已经爬过的页面),从 E 中找到 H,跟随 H,找到 I,仅此而已。G在F中找到,对该链接的爬取结束。从待取列表中,获取下一个链接继续上述操作。

爬虫不完整的PageRank爬取策略

相信很多人都知道PageRank算法。我们对SEO的通俗理解是链接传输权重的算法。而如果应用于爬虫爬取,逻辑是什么?首先,爬虫的目的是下载网页。同时,爬虫无法看到所有网页到某个网页的链接。因此,在爬取过程中,爬虫无法计算所有网页的pagerank,从而导致爬取。过程中计算出来的pagerank不是很可靠。

非完整pagerank爬取策略是基于爬虫无法看到指向某个网页的所有网页的链接,只能看到一部分情况,同时也进行pagerank的计算结果。

它的具体策略是将下载的网页和待爬取的URL列表中的网页形成一个汇总。pagerank 的计算在此摘要中执行。计算完成后,待爬取的url列表中的每一个url都会得到一个pagerank值,然后根据这个值倒序排序。先抢pagerank分数最高的,然后一个一个抢。

那么问题来了?在要爬取的URL列表中,如果最后增加了一个新的URL,是否需要重新计算?

不是这样。搜索引擎会等到待爬取的URL列表中新增的URL达到一定数量后,再重新爬取。这将大大提高效率。毕竟,爬虫抓取第一个新添加的是需要时间的。

爬虫的 OPIC 爬取策略

OPIC是onlinepageimportancecomputation的缩写,意思是“在线页面重要性计算”,是pagerank的升级版。

其具体策略逻辑如下:爬虫为互联网上的所有 URL 分配一个初始分数,每个 URL 具有相同的分数。每当下载一个网页时,这个网页的分数就会平均分配给这个页面中的所有链接。自然,这个页面的分数会被清零。在要爬取的URL列表中(当然,刚才的网页的分数被清空了,也因为已经被爬取过),根据谁的分数最高,谁的分数最高,谁就先被爬取。

与pagerank不同,opic是实时计算的。这里提醒我们,如果我们只考虑opic的抓取策略。这个策略和 pagerank 策略都证实了一个逻辑。我们新生成的网页被链接的次数越多,被抓取的可能性就越大。

是否值得考虑您的网页布局?

爬虫的大站点优先策略

大站优先爬行吗,是不是顾名思义?大的网站会先被抢?但这里有两种解释。我个人认为这两种解释爬虫都在使用中。 查看全部

抓取网页音频(SEO优化工作的6个策略之前)

【搜索引擎爬虫的五种爬取策略【seo免费教程】】搜索引擎爬虫爬取我们的网页是实现SEO优化的第一步。如果不被爬取,网站不会被搜索引擎收录列出,也不会排名。所以对于每一个SEO从业者来说,爬取是第一步!

事实上,大多数 SEO 从业者所知道的唯一搜索引擎爬取算法是深度优先和广度优先爬取。但在现实中,网页抓取有6种策略。在分享这6种策略之前,一定要了解一下搜索引擎爬虫的工作流程,否则你可能看不懂下面的内容。

爬虫的广度优先爬取策略

广度优先爬取策略,一种历史悠久、一直备受关注的爬取策略,从搜索引擎爬虫诞生之初就开始使用,甚至很多新策略都以此为基准。

广度优先爬取策略是根据待爬取的URL列表进行爬取,如果发现新的链接,则判断为没有被爬取的直接存放在待爬取URL列表的末尾,等待被抓取。

文章图片

如上图所示,我们假设爬虫的待爬取URL列表中只有A。爬虫从A网页开始爬取,从A中提取B、C、D三个网页,然后将B、C、D放入爬取队列。,然后依次获取E、F、G、H、I网页并插入到待爬取的URL列表中,如此循环往复。

爬虫的深度优先爬取策略

深度优先爬取的策略是爬虫会从待爬列表中爬取第一个URL,然后沿着这个URL继续爬取页面的其他URL,直到处理完该行,再从待爬列表中爬取,抓住第二个,依此类推。下面给出一个说明。

文章图片

A是列表中第一个要爬取的URL,爬虫开始爬取,然后爬到B、C、D、E、F,但是B、C、D没有后续链接(这个也会去掉这里)。已经爬过的页面),从 E 中找到 H,跟随 H,找到 I,仅此而已。G在F中找到,对该链接的爬取结束。从待取列表中,获取下一个链接继续上述操作。

爬虫不完整的PageRank爬取策略

相信很多人都知道PageRank算法。我们对SEO的通俗理解是链接传输权重的算法。而如果应用于爬虫爬取,逻辑是什么?首先,爬虫的目的是下载网页。同时,爬虫无法看到所有网页到某个网页的链接。因此,在爬取过程中,爬虫无法计算所有网页的pagerank,从而导致爬取。过程中计算出来的pagerank不是很可靠。

非完整pagerank爬取策略是基于爬虫无法看到指向某个网页的所有网页的链接,只能看到一部分情况,同时也进行pagerank的计算结果。

它的具体策略是将下载的网页和待爬取的URL列表中的网页形成一个汇总。pagerank 的计算在此摘要中执行。计算完成后,待爬取的url列表中的每一个url都会得到一个pagerank值,然后根据这个值倒序排序。先抢pagerank分数最高的,然后一个一个抢。

那么问题来了?在要爬取的URL列表中,如果最后增加了一个新的URL,是否需要重新计算?

不是这样。搜索引擎会等到待爬取的URL列表中新增的URL达到一定数量后,再重新爬取。这将大大提高效率。毕竟,爬虫抓取第一个新添加的是需要时间的。

爬虫的 OPIC 爬取策略

OPIC是onlinepageimportancecomputation的缩写,意思是“在线页面重要性计算”,是pagerank的升级版。

其具体策略逻辑如下:爬虫为互联网上的所有 URL 分配一个初始分数,每个 URL 具有相同的分数。每当下载一个网页时,这个网页的分数就会平均分配给这个页面中的所有链接。自然,这个页面的分数会被清零。在要爬取的URL列表中(当然,刚才的网页的分数被清空了,也因为已经被爬取过),根据谁的分数最高,谁的分数最高,谁就先被爬取。

与pagerank不同,opic是实时计算的。这里提醒我们,如果我们只考虑opic的抓取策略。这个策略和 pagerank 策略都证实了一个逻辑。我们新生成的网页被链接的次数越多,被抓取的可能性就越大。

是否值得考虑您的网页布局?

爬虫的大站点优先策略

大站优先爬行吗,是不是顾名思义?大的网站会先被抢?但这里有两种解释。我个人认为这两种解释爬虫都在使用中。

抓取网页音频(本发明专利技术提供一种基于爬虫的数据获取方法及装置)

网站优化 • 优采云 发表了文章 • 0 个评论 • 58 次浏览 • 2022-03-20 17:19

本发明专利技术提供了一种基于爬虫的数据获取方法及装置。该方法包括获取第一待爬取页面上的第一数据和至少一个跳转链接,其中至少一个跳转链接为第一待爬取页面获取该页面上可以跳转到第二待爬取页面的跳转地址,根据至少一个跳转链接进入每个跳转链接对应的第二待爬取页面,获取第二待爬取页面的信息。对于第二数据,第一数据和第二数据存储在预设的数据库中。通过获取页面中的数据实现数据抓取,通过获取页面中的跳转链接,跳转到跳转链接对应的页面,模拟手动操作浏览器的行为,

下载所有详细的技术数据

【技术实现步骤总结】

该专利技术涉及互联网

,特别是一种基于爬虫的数据采集方法和装置。

技术介绍

随着主流Web技术的飞速发展,互联网平台也在不断变化。今天,互联网由静态网页和黄页组成。用户使用博客、微博、电子公告牌(英文:Bulletin Board System,简称:BBS)、社交网站(英文:Social Network Site,简称:SNS)、新闻等各种社交网络平台评论等获取信息、评论等。基于互联网各种热点话题的信息已被广泛分析和关注,快速准确获取互联网用户数据、评论数据等数据的重要性在于突出显示。目前网络数据采集主要有两种方法:一种是使用应用程序编程接口(英文:Application Programming Interface,API)由网络本身提供,通常不能满足多方位数据分析的需要;另一种是利用传统的爬虫程序获取相关数据,需要对复杂的网页元素进行分析解析,并对需要的数据进行过滤。@网站种子的数量和类型,以种子的URL为当前URL,以种子的网站号为当前网站号,以种子的类型为当前类型;获取至少一项策略,根据策略确定至少一项爬虫爬取参数;根据当前类型获取当前类型对应的规则;根据爬虫爬取参数从当前URL中抓取网页数据,并按照规则解析网页数据,得到解析后的数据。以上两种方式都是使用传统的爬虫程序来获取网络数据。对于使用传统爬虫程序获取网络相关数据,以及通过获取页面的URL来获取静态页面中的数据,对于当今的交互式动态页面和复杂的跳转方式,传统的爬虫程序无法实现全部数据的获取。

技术实现思路

本专利技术提供了一种基于爬虫的数据获取方法及装置,实现对动态交互页面丰富的网页中数据的爬取,提高动态交互页面网页中数据爬取的速度和稳定性。本专利技术的第一方面提供了一种网络爬虫的数据抓取方法,包括:获取第一待抓取页面的第一数据和至少一个跳转链接;其中,至少一个跳转链接为第一个待爬取页面的跳转地址,可以跳转到第二个待爬取页面;根据至少一个跳转链接,进入每个跳转链接对应的第二待爬取页面,获取待爬取页面上的第二数据;将第一数据和第二数据存储在预设数据库中。进一步,所述获取第一待爬取页面的第一数据和至少一个跳转链接包括: 解析第一待爬取页面的布局, 定位第一待爬取页面上的第一页面。数据位置和至少一个跳转链接的位置;使用爬虫获取第一待爬取页面上的第一数据位置对应的第一数据,获取至少一个跳转链接,该位置对应至少一个跳转链接。可选的,分析待爬取页面的布局,定位待爬取的第一页的第一数据的位置和至少一个跳转链接的位置,包括: 使用可扩展的标记语言路径。语言解析待爬取页面的位置和布局,

进一步的,在获取第一待爬取页面上的第一数据和至少一个跳转链接之前,该方法还包括从至少一个预设的账户信息中选择第一账户信息,并将第一账户信息登录到网站@ > 待爬取页面所在位置,进入待爬取的第一页;其中,每个账号信息包括登录账号和登录密码。进一步地,该方法还包括: 检测第一账户信息是否无效;如果第一账户信息无效,标记第一账户信息,并在至少一个账户信息信息中选择第二账户;根据第二个账号信息登录网站,进入要爬取的第一页。进一步,检测抓取数据的次数和/或第一账户信息的抓取时间;当抓取数据的次数超过预设的抓取次数阈值时,从至少一个账户信息中选择第三个。账号信息,根据第三个账号信息登录网站,进入要爬取的第一页;和/或,当爬取时间超过预设的爬取时间阈值时,从至少一个账号信息中选择第三个账号信息,根据第三个账号信息登录网站,进入第一页爬行。本专利技术的第二方面提供了一种网络爬虫的数据抓取装置,包括:数据获取模块,用于获取待抓取的第一页上的第一数据和至少一个跳转链接;其中,所述至少一个跳转链接为第一待爬取页面上可以跳转到第二待爬取页面的跳转地址;处理模块,用于根据至少一个跳转链接进入每个跳转链接对应的页面。要爬取的第二个页面;数据获取模块,还用于获取第二待爬取页面的第二数据;存储模块,用于将第一数据和第二数据存储在预先设置的数据库中。处理模块,用于根据至少一个跳转链接进入每个跳转链接对应的页面。要爬取的第二个页面;数据获取模块,还用于获取第二待爬取页面的第二数据;存储模块,用于将第一数据和第二数据存储在预先设置的数据库中。处理模块,用于根据至少一个跳转链接进入每个跳转链接对应的页面。要爬取的第二个页面;数据获取模块,还用于获取第二待爬取页面的第二数据;存储模块,用于将第一数据和第二数据存储在预先设置的数据库中。

进一步地,数据获取模块具体用于: 分析第一待爬取页面的布局,定位第一待爬取页面上的第一数据位置和至少一个跳转链接的位置;通过爬虫获取待爬取的第一页上的第一数据位置对应的第一数据,并获取与至少一个跳转链接的位置对应的至少一个跳转链接。可选地,数据获取模块具体用于使用可扩展标记语言路径语言解析待爬取页面的位置和布局,得到第一数据的位置和至少一个跳转链接的位置。. 进一步地,所述处理模块还用于从至少一个预设账户信息中选择所述第一账户信息,根据第一账号信息登录待抓取页面所在的网站,输入第一账号信息。要爬取的页面;其中,每个账号信息包括登录账号和登录密码。进一步地,处理模块还用于检测第一账户信息是否无效。如果第一账户信息无效,则标记第一账户信息,并在至少一个账户信息中选择第二账户信息。帐户信息; 根据第二个账号信息登录网站,进入要爬取的第一页。进一步地,处理模块还用于检测第一账号信息的抓取数据的次数和/或抓取时间;当抓取数据的次数超过预设的抓取次数阈值时,从至少一个账号信息中选择第三个账号信息,根据第三个账号信息登录网站,输入第一个要爬取的页面;和/或,当爬取时间超过预设的爬取时间阈值时,从至少一个账户信息中选择第三个账户信息,根据第三个账户信息登录网站,输入要抓取的第一页。

本专利技术提供的一种网络爬虫的数据抓取方法及装置,通过获取第一待抓取页面上的第一数据和至少一个跳转链接,根据至少一个跳转链接进入对应的跳转链接。获取第二待爬取页面,获取第二待爬取页面的第二数据;爬取的数据存储在预设的数据库中。该专利技术通过获取页面中的数据实现数据抓取,通过获取页面中的跳转链接,跳转到跳转链接对应的页面实现页面跳转,模拟手动操作浏览器的行为,以实现交互式富动态页面的页面跳转,即使是随机生成的跳转链接,只要获取到链接,跳转到链接对应的页面,就可以实现对页面的数据抓取,解决了传统的问题。爬虫在抓取动态网页时无法获取页面所有数据的问题。附图说明为了更清楚地说明本专利技术或现有技术的技术方案,下面简要介绍描述实施例或现有技术所需的附图。显然,在下面的描述中,附图只是本专利技术的一些实施例,对于本领域的普通技术人员来说,在没有创造性劳动的情况下,还可以从这些附图中获得其他的附图。无花果。附图说明图1是本专利技术实施例提供的一种基于爬虫的数据获取方法实施例一的流程图;无花果。图2为本专利技术实施例提供的一种基于爬虫的数据获取方法实施例二的流程图;专利技术实施例提供的基于爬虫的数据获取方法第三实施例的流程图;无花果。图4为本发明专利技术实施例提供的基于爬虫的数据获取方法第三实施例的流程图;无花果。图5是专利技术实施例。提供了一种基于爬虫的数据采集装置实施例的结构示意图。优选实施例的详细说明 图2为本专利技术实施例提供的一种基于爬虫的数据获取方法实施例二的流程图;专利技术实施例提供的基于爬虫的数据获取方法第三实施例的流程图;无花果。图4为本发明专利技术实施例提供的基于爬虫的数据获取方法第三实施例的流程图;无花果。图5是专利技术实施例。提供了一种基于爬虫的数据采集装置实施例的结构示意图。优选实施例的详细说明 图2为本专利技术实施例提供的一种基于爬虫的数据获取方法实施例二的流程图;专利技术实施例提供的基于爬虫的数据获取方法第三实施例的流程图;无花果。图4为本发明专利技术实施例提供的基于爬虫的数据获取方法第三实施例的流程图;无花果。图5是专利技术实施例。提供了一种基于爬虫的数据采集装置实施例的结构示意图。优选实施例的详细说明 图4为本发明专利技术实施例提供的基于爬虫的数据获取方法第三实施例的流程图;无花果。图5是专利技术实施例。提供了一种基于爬虫的数据采集装置实施例的结构示意图。优选实施例的详细说明 图4为本发明专利技术实施例提供的基于爬虫的数据获取方法第三实施例的流程图;无花果。图5是专利技术实施例。提供了一种基于爬虫的数据采集装置实施例的结构示意图。优选实施例的详细说明

【技术保护点】

一种基于爬虫的数据获取方法,包括: 获取第一待爬取页面上的第一数据和至少一个跳转链接;其中,所述至少一个跳转链接为第一个待爬取页面,获取可以跳转到第二个待爬取页面的页面上的跳转地址;根据至少一个跳转链接,进入每个跳转链接对应的第二待爬取页面,获取第二待爬取页面获取页面上的第二数据;将第一数据和第二数据存储在预设数据库中。

【技术特点总结】

1.一种基于爬虫的数据获取方法,其特征在于,包括:获取第一待爬取页面上的第一数据和至少一个跳转链接;其中,所述至少一个跳转链接是所有第一个待爬取页面都可以跳转到第二个待爬取页面的跳转地址;根据至少一个跳转链接,进入每个跳转链接对应的第二待爬取页面,获取第二待爬取页面上的所有第二数据;将第一数据和第二数据存储在预设数据库中。2.根据权利要求1所述的方法,其特征在于,所述获取第一待爬取页面的第一数据和至少一个跳转链接包括: 解析第一待爬取页面布局,定位第一数据在待爬取页面上的位置。待爬取的第一页和至少一个跳转链接的位置;使用爬虫方法获取第一数据在第一待爬取页面上的对应位置以及获取到至少一个跳转链接的位置对应的至少一个跳转链接。3.如权利要求2所述的方法,其特征在于,所述分析待爬取页面的布局,定位待爬取的第一页的第一数据的位置和所述至少一个跳转链接的位置包括:使用Extensible Markup Language Path Language解析待爬取页面的位置和布局,获取第一条数据的位置和至少一个跳转链接的位置。4.根据权利要求1至3任一项所述的方法,其特征在于,在获取所述第一数据和所述第一待爬取页面上的至少一个跳转链接之前,该方法还包括: 从预设的至少一个账户信息中选择第一账户信息,根据第一账户信息登录待爬取页面所在的网站,进入第一页面被爬取;其中,每个账号信息包括登录账号和登录密码。5.根据权利要求4所述的方法,其特征在于,所述方法还包括: 检测所述第一账户信息是否无效;如果第一账户信息无效,则执行第一账户信息标记,从至少一个账户信息中选择第二账户信息;根据第二个账号信息登录网站,进入要爬取的第一页。6.如权利要求4所述的方法,其特征在于... 从预设的至少一个账号信息中选择第一账号信息,根据第一账号信息登录待爬取页面所在的网站,进入第一待爬取页面;其中,每个账号信息包括登录账号和登录密码。5.根据权利要求4所述的方法,其特征在于,所述方法还包括: 检测所述第一账户信息是否无效;如果第一账户信息无效,则执行第一账户信息标记,从至少一个账户信息中选择第二账户信息;根据第二个账号信息登录网站,进入要爬取的第一页。6.如权利要求4所述的方法,其特征在于... 从预设的至少一个账号信息中选择第一账号信息,根据第一账号信息登录待爬取页面所在的网站,进入第一待爬取页面;其中,每个账号信息包括登录账号和登录密码。5.根据权利要求4所述的方法,其特征在于,所述方法还包括: 检测所述第一账户信息是否无效;如果第一账户信息无效,则执行第一账户信息标记,从至少一个账户信息中选择第二账户信息;根据第二个账号信息登录网站,进入要爬取的第一页。6.如权利要求4所述的方法,其特征在于...

【专利技术性质】

技术研发人员:陈健,

申请人(专利权)持有人:北京邮电大学,

类型:发明

国家、省、市:北京;11

下载所有详细的技术数据 我是该专利的所有者 查看全部

抓取网页音频(本发明专利技术提供一种基于爬虫的数据获取方法及装置)

本发明专利技术提供了一种基于爬虫的数据获取方法及装置。该方法包括获取第一待爬取页面上的第一数据和至少一个跳转链接,其中至少一个跳转链接为第一待爬取页面获取该页面上可以跳转到第二待爬取页面的跳转地址,根据至少一个跳转链接进入每个跳转链接对应的第二待爬取页面,获取第二待爬取页面的信息。对于第二数据,第一数据和第二数据存储在预设的数据库中。通过获取页面中的数据实现数据抓取,通过获取页面中的跳转链接,跳转到跳转链接对应的页面,模拟手动操作浏览器的行为,

下载所有详细的技术数据

【技术实现步骤总结】

该专利技术涉及互联网

,特别是一种基于爬虫的数据采集方法和装置。

技术介绍

随着主流Web技术的飞速发展,互联网平台也在不断变化。今天,互联网由静态网页和黄页组成。用户使用博客、微博、电子公告牌(英文:Bulletin Board System,简称:BBS)、社交网站(英文:Social Network Site,简称:SNS)、新闻等各种社交网络平台评论等获取信息、评论等。基于互联网各种热点话题的信息已被广泛分析和关注,快速准确获取互联网用户数据、评论数据等数据的重要性在于突出显示。目前网络数据采集主要有两种方法:一种是使用应用程序编程接口(英文:Application Programming Interface,API)由网络本身提供,通常不能满足多方位数据分析的需要;另一种是利用传统的爬虫程序获取相关数据,需要对复杂的网页元素进行分析解析,并对需要的数据进行过滤。@网站种子的数量和类型,以种子的URL为当前URL,以种子的网站号为当前网站号,以种子的类型为当前类型;获取至少一项策略,根据策略确定至少一项爬虫爬取参数;根据当前类型获取当前类型对应的规则;根据爬虫爬取参数从当前URL中抓取网页数据,并按照规则解析网页数据,得到解析后的数据。以上两种方式都是使用传统的爬虫程序来获取网络数据。对于使用传统爬虫程序获取网络相关数据,以及通过获取页面的URL来获取静态页面中的数据,对于当今的交互式动态页面和复杂的跳转方式,传统的爬虫程序无法实现全部数据的获取。

技术实现思路

本专利技术提供了一种基于爬虫的数据获取方法及装置,实现对动态交互页面丰富的网页中数据的爬取,提高动态交互页面网页中数据爬取的速度和稳定性。本专利技术的第一方面提供了一种网络爬虫的数据抓取方法,包括:获取第一待抓取页面的第一数据和至少一个跳转链接;其中,至少一个跳转链接为第一个待爬取页面的跳转地址,可以跳转到第二个待爬取页面;根据至少一个跳转链接,进入每个跳转链接对应的第二待爬取页面,获取待爬取页面上的第二数据;将第一数据和第二数据存储在预设数据库中。进一步,所述获取第一待爬取页面的第一数据和至少一个跳转链接包括: 解析第一待爬取页面的布局, 定位第一待爬取页面上的第一页面。数据位置和至少一个跳转链接的位置;使用爬虫获取第一待爬取页面上的第一数据位置对应的第一数据,获取至少一个跳转链接,该位置对应至少一个跳转链接。可选的,分析待爬取页面的布局,定位待爬取的第一页的第一数据的位置和至少一个跳转链接的位置,包括: 使用可扩展的标记语言路径。语言解析待爬取页面的位置和布局,

进一步的,在获取第一待爬取页面上的第一数据和至少一个跳转链接之前,该方法还包括从至少一个预设的账户信息中选择第一账户信息,并将第一账户信息登录到网站@ > 待爬取页面所在位置,进入待爬取的第一页;其中,每个账号信息包括登录账号和登录密码。进一步地,该方法还包括: 检测第一账户信息是否无效;如果第一账户信息无效,标记第一账户信息,并在至少一个账户信息信息中选择第二账户;根据第二个账号信息登录网站,进入要爬取的第一页。进一步,检测抓取数据的次数和/或第一账户信息的抓取时间;当抓取数据的次数超过预设的抓取次数阈值时,从至少一个账户信息中选择第三个。账号信息,根据第三个账号信息登录网站,进入要爬取的第一页;和/或,当爬取时间超过预设的爬取时间阈值时,从至少一个账号信息中选择第三个账号信息,根据第三个账号信息登录网站,进入第一页爬行。本专利技术的第二方面提供了一种网络爬虫的数据抓取装置,包括:数据获取模块,用于获取待抓取的第一页上的第一数据和至少一个跳转链接;其中,所述至少一个跳转链接为第一待爬取页面上可以跳转到第二待爬取页面的跳转地址;处理模块,用于根据至少一个跳转链接进入每个跳转链接对应的页面。要爬取的第二个页面;数据获取模块,还用于获取第二待爬取页面的第二数据;存储模块,用于将第一数据和第二数据存储在预先设置的数据库中。处理模块,用于根据至少一个跳转链接进入每个跳转链接对应的页面。要爬取的第二个页面;数据获取模块,还用于获取第二待爬取页面的第二数据;存储模块,用于将第一数据和第二数据存储在预先设置的数据库中。处理模块,用于根据至少一个跳转链接进入每个跳转链接对应的页面。要爬取的第二个页面;数据获取模块,还用于获取第二待爬取页面的第二数据;存储模块,用于将第一数据和第二数据存储在预先设置的数据库中。

进一步地,数据获取模块具体用于: 分析第一待爬取页面的布局,定位第一待爬取页面上的第一数据位置和至少一个跳转链接的位置;通过爬虫获取待爬取的第一页上的第一数据位置对应的第一数据,并获取与至少一个跳转链接的位置对应的至少一个跳转链接。可选地,数据获取模块具体用于使用可扩展标记语言路径语言解析待爬取页面的位置和布局,得到第一数据的位置和至少一个跳转链接的位置。. 进一步地,所述处理模块还用于从至少一个预设账户信息中选择所述第一账户信息,根据第一账号信息登录待抓取页面所在的网站,输入第一账号信息。要爬取的页面;其中,每个账号信息包括登录账号和登录密码。进一步地,处理模块还用于检测第一账户信息是否无效。如果第一账户信息无效,则标记第一账户信息,并在至少一个账户信息中选择第二账户信息。帐户信息; 根据第二个账号信息登录网站,进入要爬取的第一页。进一步地,处理模块还用于检测第一账号信息的抓取数据的次数和/或抓取时间;当抓取数据的次数超过预设的抓取次数阈值时,从至少一个账号信息中选择第三个账号信息,根据第三个账号信息登录网站,输入第一个要爬取的页面;和/或,当爬取时间超过预设的爬取时间阈值时,从至少一个账户信息中选择第三个账户信息,根据第三个账户信息登录网站,输入要抓取的第一页。

本专利技术提供的一种网络爬虫的数据抓取方法及装置,通过获取第一待抓取页面上的第一数据和至少一个跳转链接,根据至少一个跳转链接进入对应的跳转链接。获取第二待爬取页面,获取第二待爬取页面的第二数据;爬取的数据存储在预设的数据库中。该专利技术通过获取页面中的数据实现数据抓取,通过获取页面中的跳转链接,跳转到跳转链接对应的页面实现页面跳转,模拟手动操作浏览器的行为,以实现交互式富动态页面的页面跳转,即使是随机生成的跳转链接,只要获取到链接,跳转到链接对应的页面,就可以实现对页面的数据抓取,解决了传统的问题。爬虫在抓取动态网页时无法获取页面所有数据的问题。附图说明为了更清楚地说明本专利技术或现有技术的技术方案,下面简要介绍描述实施例或现有技术所需的附图。显然,在下面的描述中,附图只是本专利技术的一些实施例,对于本领域的普通技术人员来说,在没有创造性劳动的情况下,还可以从这些附图中获得其他的附图。无花果。附图说明图1是本专利技术实施例提供的一种基于爬虫的数据获取方法实施例一的流程图;无花果。图2为本专利技术实施例提供的一种基于爬虫的数据获取方法实施例二的流程图;专利技术实施例提供的基于爬虫的数据获取方法第三实施例的流程图;无花果。图4为本发明专利技术实施例提供的基于爬虫的数据获取方法第三实施例的流程图;无花果。图5是专利技术实施例。提供了一种基于爬虫的数据采集装置实施例的结构示意图。优选实施例的详细说明 图2为本专利技术实施例提供的一种基于爬虫的数据获取方法实施例二的流程图;专利技术实施例提供的基于爬虫的数据获取方法第三实施例的流程图;无花果。图4为本发明专利技术实施例提供的基于爬虫的数据获取方法第三实施例的流程图;无花果。图5是专利技术实施例。提供了一种基于爬虫的数据采集装置实施例的结构示意图。优选实施例的详细说明 图2为本专利技术实施例提供的一种基于爬虫的数据获取方法实施例二的流程图;专利技术实施例提供的基于爬虫的数据获取方法第三实施例的流程图;无花果。图4为本发明专利技术实施例提供的基于爬虫的数据获取方法第三实施例的流程图;无花果。图5是专利技术实施例。提供了一种基于爬虫的数据采集装置实施例的结构示意图。优选实施例的详细说明 图4为本发明专利技术实施例提供的基于爬虫的数据获取方法第三实施例的流程图;无花果。图5是专利技术实施例。提供了一种基于爬虫的数据采集装置实施例的结构示意图。优选实施例的详细说明 图4为本发明专利技术实施例提供的基于爬虫的数据获取方法第三实施例的流程图;无花果。图5是专利技术实施例。提供了一种基于爬虫的数据采集装置实施例的结构示意图。优选实施例的详细说明

【技术保护点】

一种基于爬虫的数据获取方法,包括: 获取第一待爬取页面上的第一数据和至少一个跳转链接;其中,所述至少一个跳转链接为第一个待爬取页面,获取可以跳转到第二个待爬取页面的页面上的跳转地址;根据至少一个跳转链接,进入每个跳转链接对应的第二待爬取页面,获取第二待爬取页面获取页面上的第二数据;将第一数据和第二数据存储在预设数据库中。

【技术特点总结】

1.一种基于爬虫的数据获取方法,其特征在于,包括:获取第一待爬取页面上的第一数据和至少一个跳转链接;其中,所述至少一个跳转链接是所有第一个待爬取页面都可以跳转到第二个待爬取页面的跳转地址;根据至少一个跳转链接,进入每个跳转链接对应的第二待爬取页面,获取第二待爬取页面上的所有第二数据;将第一数据和第二数据存储在预设数据库中。2.根据权利要求1所述的方法,其特征在于,所述获取第一待爬取页面的第一数据和至少一个跳转链接包括: 解析第一待爬取页面布局,定位第一数据在待爬取页面上的位置。待爬取的第一页和至少一个跳转链接的位置;使用爬虫方法获取第一数据在第一待爬取页面上的对应位置以及获取到至少一个跳转链接的位置对应的至少一个跳转链接。3.如权利要求2所述的方法,其特征在于,所述分析待爬取页面的布局,定位待爬取的第一页的第一数据的位置和所述至少一个跳转链接的位置包括:使用Extensible Markup Language Path Language解析待爬取页面的位置和布局,获取第一条数据的位置和至少一个跳转链接的位置。4.根据权利要求1至3任一项所述的方法,其特征在于,在获取所述第一数据和所述第一待爬取页面上的至少一个跳转链接之前,该方法还包括: 从预设的至少一个账户信息中选择第一账户信息,根据第一账户信息登录待爬取页面所在的网站,进入第一页面被爬取;其中,每个账号信息包括登录账号和登录密码。5.根据权利要求4所述的方法,其特征在于,所述方法还包括: 检测所述第一账户信息是否无效;如果第一账户信息无效,则执行第一账户信息标记,从至少一个账户信息中选择第二账户信息;根据第二个账号信息登录网站,进入要爬取的第一页。6.如权利要求4所述的方法,其特征在于... 从预设的至少一个账号信息中选择第一账号信息,根据第一账号信息登录待爬取页面所在的网站,进入第一待爬取页面;其中,每个账号信息包括登录账号和登录密码。5.根据权利要求4所述的方法,其特征在于,所述方法还包括: 检测所述第一账户信息是否无效;如果第一账户信息无效,则执行第一账户信息标记,从至少一个账户信息中选择第二账户信息;根据第二个账号信息登录网站,进入要爬取的第一页。6.如权利要求4所述的方法,其特征在于... 从预设的至少一个账号信息中选择第一账号信息,根据第一账号信息登录待爬取页面所在的网站,进入第一待爬取页面;其中,每个账号信息包括登录账号和登录密码。5.根据权利要求4所述的方法,其特征在于,所述方法还包括: 检测所述第一账户信息是否无效;如果第一账户信息无效,则执行第一账户信息标记,从至少一个账户信息中选择第二账户信息;根据第二个账号信息登录网站,进入要爬取的第一页。6.如权利要求4所述的方法,其特征在于...

【专利技术性质】

技术研发人员:陈健,

申请人(专利权)持有人:北京邮电大学,

类型:发明

国家、省、市:北京;11

下载所有详细的技术数据 我是该专利的所有者

抓取网页音频(搜狗浏览器修改缓存目录,你需要知道的事儿!)

网站优化 • 优采云 发表了文章 • 0 个评论 • 133 次浏览 • 2022-03-19 09:09

1、打开搜狗浏览器,找到右上角的【选项】

2、【第一个缓存目录】一般是IE的缓存目录,但这里也有一些缓存。

3、找到右上角【Internet选项】

4、进入【Internet选项】,找到【设置】

5、进入【设置】,找到【查看文件】,输入为【第一缓存目录】。

6、【二级缓存目录】搜狗key目录。

7、同上,在右上角找到【选项】,进入这个页面,找到【高级】

8、进入【高级】,下拉菜单找到【更多高级设置】

9、进入【更多高级设置】点击【继续】进入【实验室】,也就是【二级缓存目录】。

10、一般默认目录在AppData\Roaming\SogouExplorer\Webkit中缓存最多的文件,如视频、音乐等,

在 AppData\Roaming\SogouExplorer\Webkit\Default 目录下的这两个文件夹中。可以根据时间判断是否为当前目标缓存文件。另一种方法是记下目标网址,清除缓存,重新打开搜狗浏览器输入网址,得到的缓存文件就是目标文件。

11、如果【自定义缓存目录】为默认目录,但找不到目标缓存目录,可以点击【浏览】修改缓存目录,设置为可以找到的目录。【注意】修改缓存目录后,缓存文件会在一段时间后缓存到指定目录。 查看全部

抓取网页音频(搜狗浏览器修改缓存目录,你需要知道的事儿!)

1、打开搜狗浏览器,找到右上角的【选项】

2、【第一个缓存目录】一般是IE的缓存目录,但这里也有一些缓存。

3、找到右上角【Internet选项】

4、进入【Internet选项】,找到【设置】

5、进入【设置】,找到【查看文件】,输入为【第一缓存目录】。

6、【二级缓存目录】搜狗key目录。

7、同上,在右上角找到【选项】,进入这个页面,找到【高级】

8、进入【高级】,下拉菜单找到【更多高级设置】

9、进入【更多高级设置】点击【继续】进入【实验室】,也就是【二级缓存目录】。

10、一般默认目录在AppData\Roaming\SogouExplorer\Webkit中缓存最多的文件,如视频、音乐等,

在 AppData\Roaming\SogouExplorer\Webkit\Default 目录下的这两个文件夹中。可以根据时间判断是否为当前目标缓存文件。另一种方法是记下目标网址,清除缓存,重新打开搜狗浏览器输入网址,得到的缓存文件就是目标文件。

11、如果【自定义缓存目录】为默认目录,但找不到目标缓存目录,可以点击【浏览】修改缓存目录,设置为可以找到的目录。【注意】修改缓存目录后,缓存文件会在一段时间后缓存到指定目录。

抓取网页音频(你用dsp的真是天才吗?呗!!)

网站优化 • 优采云 发表了文章 • 0 个评论 • 82 次浏览 • 2022-03-18 16:01

抓取网页音频可以实现有效的波段合成,实现清晰度的编码,保留原始音频清晰度。由于信息量更大了,音频质量编码效果优化,传输效率提高。只能说现在技术和ip价格下有效果但前景不明朗。要说环保可以考虑无线加密传输,然后有效率编码,使用aes加密也可以的。但是不是无线和编码也是另外一个问题了。

你用dsp的真是天才。不过确实就是用的dsp呗。还是dsp。

看了答案,大家都在说dsp,这么说吧,如果网站没有公开获取访问者的访问策略,那你就只能给他所有的信息了,以前没有调制就给个噪声信号,你打开网站听到的声音就是噪声,有dsp就给你一个纯波形,只显示前20位,根据前20位分布来显示噪声频谱,那听你打开网站的噪声信号多明显,如果你看看你家的wifi广播,广播里面的也就是这种波形,这种波形其实是频谱机制决定的,用dsp来处理,就是解调了,解调里面的调制没问题,波形分布就没问题,dsp和da,ca是一样的,不过da就是合成,da本身自带调制,da一样用dsp,如果你用api,还能分成1024个广播波形数据块,由da,a,f,g,c,h,e,i组成的另一套波形数据帧来调制,allspecified,来调制我们人耳听到的声音。

离线这个不用你控制呀(离线无延迟那就好了,手机播放也是这样)da本身能解调也就是模拟信号啊, 查看全部

抓取网页音频(你用dsp的真是天才吗?呗!!)

抓取网页音频可以实现有效的波段合成,实现清晰度的编码,保留原始音频清晰度。由于信息量更大了,音频质量编码效果优化,传输效率提高。只能说现在技术和ip价格下有效果但前景不明朗。要说环保可以考虑无线加密传输,然后有效率编码,使用aes加密也可以的。但是不是无线和编码也是另外一个问题了。

你用dsp的真是天才。不过确实就是用的dsp呗。还是dsp。

看了答案,大家都在说dsp,这么说吧,如果网站没有公开获取访问者的访问策略,那你就只能给他所有的信息了,以前没有调制就给个噪声信号,你打开网站听到的声音就是噪声,有dsp就给你一个纯波形,只显示前20位,根据前20位分布来显示噪声频谱,那听你打开网站的噪声信号多明显,如果你看看你家的wifi广播,广播里面的也就是这种波形,这种波形其实是频谱机制决定的,用dsp来处理,就是解调了,解调里面的调制没问题,波形分布就没问题,dsp和da,ca是一样的,不过da就是合成,da本身自带调制,da一样用dsp,如果你用api,还能分成1024个广播波形数据块,由da,a,f,g,c,h,e,i组成的另一套波形数据帧来调制,allspecified,来调制我们人耳听到的声音。

离线这个不用你控制呀(离线无延迟那就好了,手机播放也是这样)da本身能解调也就是模拟信号啊,

抓取网页音频(2021-10-131聚焦爬虫工作原理及关键技术概述)

网站优化 • 优采云 发表了文章 • 0 个评论 • 121 次浏览 • 2022-03-17 09:29

2021-10-13

1 重点介绍爬虫的工作原理及关键技术概述

网络爬虫是一种自动提取网页的程序。它从互联网上为搜索引擎下载网页,是搜索引擎的重要组成部分。传统爬虫从一个或多个初始网页的URL开始,获取初始网页上的URL。在抓取网页的过程中,它不断地从当前页面中提取新的 URL 并放入队列中,直到满足系统的某些停止条件。焦点爬虫的工作流程比较复杂。它需要按照一定的网页分析算法过滤掉与主题无关的链接,保留有用的链接,并放入等待抓取的URL队列中。然后,它会根据一定的搜索策略从队列中选择下一个要爬取的网页URL,并重复上述过程,直到系统达到一定条件并停止。存储、执行一定的分析、过滤、建立索引,以供后续查询和检索;对于重点爬虫来说,这个过程中得到的分析结果也可以为后续的爬取过程提供反馈和指导。

与通用网络爬虫相比,聚焦爬虫还需要解决三个主要问题:

(1) 获取目标的描述或定义;

(2) 网页或数据的分析和过滤;

(3) URL 的搜索策略。

爬取目标的描述和定义是决定如何制定网页分析算法和URL搜索策略的基础。网页分析算法和候选URL排序算法是确定搜索引擎提供的服务形式和爬虫爬取行为的关键。这两部分的算法密切相关。

2 爬取目标描述

现有的焦点爬虫对爬取目标的描述可以分为三种类型:基于目标网页的特征、基于目标数据模式和基于领域概念。爬虫根据目标网页的特征爬取、存储和索引的对象一般为网站或网页。根据种子样品的获取方式,可分为:

(1) 预先给定的初始抓取种子样本;

(2) 预先给定的网页类别和类别对应的种子样本,如Yahoo!类别结构等;

(3) 由用户行为决定的抓取目标示例分为:

a) 在用户浏览过程中显示标记的抓取样本;

b) 通过用户日志挖掘获取访问模式和相关样本。

网页特征可以是网页的内容特征,也可以是网页的链接结构特征等。

现有的焦点爬虫对爬取目标的描述或定义可以分为三种类型:基于目标网页的特征、基于目标数据模式和基于领域概念。爬虫根据目标网页的特征爬取、存储和索引的对象一般为网站或网页。具体方法可以分为:(1)Pre-given初始抓取种子样本;(2)预先给定网页类别和类别对应的种子样本),如Yahoo!分类结构,等;(3)由用户行为决定的爬取目标样本。其中,网页特征可以是网页的内容特征,也可以是网页的链接结构特征等。

基于目标数据模式的爬虫针对网页上的数据,抓取到的数据一般都符合一定的模式,或者可以转化或映射成目标数据模式。

另一种描述方式是构建目标域的本体或字典,用于从语义角度分析主题中不同特征的重要性。

3 网络搜索策略

网页抓取策略可以分为三种类型:深度优先、广度优先和最佳优先。深度优先在很多情况下会导致爬虫被困的问题。目前,广度优先和最佳优先方法很常见。

3.1 广度优先搜索策略

广度优先搜索策略是指在爬取过程中,完成当前一级搜索后,再进行下一级搜索。该算法的设计和实现比较简单。目前,为了覆盖尽可能多的网页,一般采用广度优先搜索方式。也有许多研究将广度优先搜索策略应用于聚焦爬虫。其基本思想是距初始 URL 一定链接距离内的网页具有较高的主题相关性概率。另一种方法是将广度优先搜索与网页过滤技术相结合,首先使用广度优先策略抓取网页,然后过滤掉不相关的页面。这些方法的缺点是随着爬取的网页数量的增加,

3.2 最佳优先搜索策略

最佳优先级搜索策略是根据一定的网页分析算法预测候选URL与目标网页的相似度,或与主题的相关度,选择评价最好的一个或几个URL进行爬取。它只访问页面分析算法预测为“有用”的页面。一个问题是爬虫爬取路径上的许多相关网页可能会被忽略,因为最佳优先策略是局部最优搜索算法。因此,需要将最佳优先级与具体应用结合起来进行改进,从而跳出局部最优点。在第 4 节中,将结合网页分析算法进行详细讨论。

4 网页分析算法

网页分析算法可以分为三类:基于网络拓扑、基于网页内容和基于用户访问行为。

4.1 基于网络拓扑的分析算法

基于网页之间的链接,通过已知的网页或数据,评估与其有直接或间接链接关系的对象(可以是网页或网站等)的算法。进一步分为三种:网页粒度、网站粒度和网页块粒度。

4.1.1 网页粒度分析算法

PageRank 和 HITS 算法是最常见的链接分析算法。两者都是通过网页间链接度的递归归一化计算得到每个网页的重要性。PageRank算法虽然考虑了用户访问行为的随机性和Sink网页的存在性,但忽略了大部分用户访问的目的性,即网页和查询主题链接的相关性。针对这个问题,HITS算法提出了两个关键概念:权威网页(authority)和中心网页(hub)。

基于链接的爬取问题是相关页面的主题组之间存在隧道现象,即爬取路径上很多偏离主题的页面也指向目标页面,局部评价策略中断了爬取行为当前路径。参考文献[21]提出了一种基于反向链接(BackLink)的层次上下文模型(Context Model),用于描述指向一定物理跳半径内的目标网页的网页拓扑图的中心Layer 0作为目标网页。网页根据指向目标网页的物理跳数进行层次划分,外层网页到内层网页的链接称为反向链接。

4.1.2 网站粒度分析算法

网站粒度资源发现和管理策略也比网页粒度更简单有效。网站粒度爬取的关键是站点的划分和SiteRank的计算。SiteRank的计算方法与PageRank类似,但需要对网站之间的链接进行一定程度的抽象,并在一定模型下计算链接的权重。网站划分分为两种:按域名划分和按IP地址划分。参考文献[18]讨论了分布式情况下,通过划分同一域名下不同主机和服务器的IP地址,构建站点地图,并采用类似于PageRank的方法评估SiteRank。同时,根据不同文件在各个站点的分布情况,构建文档图,结合SiteRank分布式计算得到DocRank。参考文献[18]证明,使用分布式SiteRank计算不仅大大降低了单个站点的算法成本,而且克服了单个站点对全网覆盖范围有限的缺点。一个额外的好处是,常见的 PageRank 欺诈很难欺骗 SiteRank。

4.1.3 网页块粒度分析算法

一个页面往往收录多个指向其他页面的链接,而这些链接中只有一部分指向与主题相关的网页,或者根据网页的链接锚文本表明其重要性高。但是在PageRank和HITS算法中,这些链接是没有区分的,所以往往会给网页分析带来广告等噪声链接的干扰。页块级链接分析算法的基本思想是通过VIPS页面分割算法将页面划分为不同的页块,然后为这些页块建立页到块和块到页的链接。矩阵,分别表示为 Z 和 X。因此,页到页图上页块级的PageRank为W p=X×Z;块到块图上的 BlockRank 是 W b=Z×X。

4.2 基于网页内容的网页分析算法

基于网页内容的分析算法是指利用网页内容的特征(文本、数据等资源)对网页进行评价。网页的内容已经从基于超文本的内容演变为动态页面(或称为Hidden Web)数据,后者的数据量约为直接可见页面数据(PIW,Publicly Indexable Web)的400~500%。次。另一方面,多媒体数据、Web Service等各种形式的网络资源日益丰富。因此,基于网页内容的分析算法也从最初的相对简单的文本检索方法发展到综合应用包括网页数据提取、机器学习、数据挖掘、语义理解等多种方法。本节根据网页数据的不同形式,

第一种是针对以文本和超链接为主的非结构化或非常简单的网页;

二是针对结构化数据源(如RDBMS)动态生成的页面,其数据不能直接批量访问;

第三类目标数据介于第一类和第二类数据之间,结构更好,表明它遵循一定的模式或风格,可以直接访问。

分类:

技术要点:

相关文章: 查看全部

抓取网页音频(2021-10-131聚焦爬虫工作原理及关键技术概述)

2021-10-13

1 重点介绍爬虫的工作原理及关键技术概述

网络爬虫是一种自动提取网页的程序。它从互联网上为搜索引擎下载网页,是搜索引擎的重要组成部分。传统爬虫从一个或多个初始网页的URL开始,获取初始网页上的URL。在抓取网页的过程中,它不断地从当前页面中提取新的 URL 并放入队列中,直到满足系统的某些停止条件。焦点爬虫的工作流程比较复杂。它需要按照一定的网页分析算法过滤掉与主题无关的链接,保留有用的链接,并放入等待抓取的URL队列中。然后,它会根据一定的搜索策略从队列中选择下一个要爬取的网页URL,并重复上述过程,直到系统达到一定条件并停止。存储、执行一定的分析、过滤、建立索引,以供后续查询和检索;对于重点爬虫来说,这个过程中得到的分析结果也可以为后续的爬取过程提供反馈和指导。

与通用网络爬虫相比,聚焦爬虫还需要解决三个主要问题:

(1) 获取目标的描述或定义;

(2) 网页或数据的分析和过滤;

(3) URL 的搜索策略。

爬取目标的描述和定义是决定如何制定网页分析算法和URL搜索策略的基础。网页分析算法和候选URL排序算法是确定搜索引擎提供的服务形式和爬虫爬取行为的关键。这两部分的算法密切相关。

2 爬取目标描述

现有的焦点爬虫对爬取目标的描述可以分为三种类型:基于目标网页的特征、基于目标数据模式和基于领域概念。爬虫根据目标网页的特征爬取、存储和索引的对象一般为网站或网页。根据种子样品的获取方式,可分为:

(1) 预先给定的初始抓取种子样本;

(2) 预先给定的网页类别和类别对应的种子样本,如Yahoo!类别结构等;

(3) 由用户行为决定的抓取目标示例分为:

a) 在用户浏览过程中显示标记的抓取样本;

b) 通过用户日志挖掘获取访问模式和相关样本。

网页特征可以是网页的内容特征,也可以是网页的链接结构特征等。

现有的焦点爬虫对爬取目标的描述或定义可以分为三种类型:基于目标网页的特征、基于目标数据模式和基于领域概念。爬虫根据目标网页的特征爬取、存储和索引的对象一般为网站或网页。具体方法可以分为:(1)Pre-given初始抓取种子样本;(2)预先给定网页类别和类别对应的种子样本),如Yahoo!分类结构,等;(3)由用户行为决定的爬取目标样本。其中,网页特征可以是网页的内容特征,也可以是网页的链接结构特征等。

基于目标数据模式的爬虫针对网页上的数据,抓取到的数据一般都符合一定的模式,或者可以转化或映射成目标数据模式。

另一种描述方式是构建目标域的本体或字典,用于从语义角度分析主题中不同特征的重要性。

3 网络搜索策略

网页抓取策略可以分为三种类型:深度优先、广度优先和最佳优先。深度优先在很多情况下会导致爬虫被困的问题。目前,广度优先和最佳优先方法很常见。

3.1 广度优先搜索策略

广度优先搜索策略是指在爬取过程中,完成当前一级搜索后,再进行下一级搜索。该算法的设计和实现比较简单。目前,为了覆盖尽可能多的网页,一般采用广度优先搜索方式。也有许多研究将广度优先搜索策略应用于聚焦爬虫。其基本思想是距初始 URL 一定链接距离内的网页具有较高的主题相关性概率。另一种方法是将广度优先搜索与网页过滤技术相结合,首先使用广度优先策略抓取网页,然后过滤掉不相关的页面。这些方法的缺点是随着爬取的网页数量的增加,

3.2 最佳优先搜索策略

最佳优先级搜索策略是根据一定的网页分析算法预测候选URL与目标网页的相似度,或与主题的相关度,选择评价最好的一个或几个URL进行爬取。它只访问页面分析算法预测为“有用”的页面。一个问题是爬虫爬取路径上的许多相关网页可能会被忽略,因为最佳优先策略是局部最优搜索算法。因此,需要将最佳优先级与具体应用结合起来进行改进,从而跳出局部最优点。在第 4 节中,将结合网页分析算法进行详细讨论。

4 网页分析算法

网页分析算法可以分为三类:基于网络拓扑、基于网页内容和基于用户访问行为。

4.1 基于网络拓扑的分析算法

基于网页之间的链接,通过已知的网页或数据,评估与其有直接或间接链接关系的对象(可以是网页或网站等)的算法。进一步分为三种:网页粒度、网站粒度和网页块粒度。

4.1.1 网页粒度分析算法

PageRank 和 HITS 算法是最常见的链接分析算法。两者都是通过网页间链接度的递归归一化计算得到每个网页的重要性。PageRank算法虽然考虑了用户访问行为的随机性和Sink网页的存在性,但忽略了大部分用户访问的目的性,即网页和查询主题链接的相关性。针对这个问题,HITS算法提出了两个关键概念:权威网页(authority)和中心网页(hub)。

基于链接的爬取问题是相关页面的主题组之间存在隧道现象,即爬取路径上很多偏离主题的页面也指向目标页面,局部评价策略中断了爬取行为当前路径。参考文献[21]提出了一种基于反向链接(BackLink)的层次上下文模型(Context Model),用于描述指向一定物理跳半径内的目标网页的网页拓扑图的中心Layer 0作为目标网页。网页根据指向目标网页的物理跳数进行层次划分,外层网页到内层网页的链接称为反向链接。

4.1.2 网站粒度分析算法

网站粒度资源发现和管理策略也比网页粒度更简单有效。网站粒度爬取的关键是站点的划分和SiteRank的计算。SiteRank的计算方法与PageRank类似,但需要对网站之间的链接进行一定程度的抽象,并在一定模型下计算链接的权重。网站划分分为两种:按域名划分和按IP地址划分。参考文献[18]讨论了分布式情况下,通过划分同一域名下不同主机和服务器的IP地址,构建站点地图,并采用类似于PageRank的方法评估SiteRank。同时,根据不同文件在各个站点的分布情况,构建文档图,结合SiteRank分布式计算得到DocRank。参考文献[18]证明,使用分布式SiteRank计算不仅大大降低了单个站点的算法成本,而且克服了单个站点对全网覆盖范围有限的缺点。一个额外的好处是,常见的 PageRank 欺诈很难欺骗 SiteRank。

4.1.3 网页块粒度分析算法

一个页面往往收录多个指向其他页面的链接,而这些链接中只有一部分指向与主题相关的网页,或者根据网页的链接锚文本表明其重要性高。但是在PageRank和HITS算法中,这些链接是没有区分的,所以往往会给网页分析带来广告等噪声链接的干扰。页块级链接分析算法的基本思想是通过VIPS页面分割算法将页面划分为不同的页块,然后为这些页块建立页到块和块到页的链接。矩阵,分别表示为 Z 和 X。因此,页到页图上页块级的PageRank为W p=X×Z;块到块图上的 BlockRank 是 W b=Z×X。

4.2 基于网页内容的网页分析算法

基于网页内容的分析算法是指利用网页内容的特征(文本、数据等资源)对网页进行评价。网页的内容已经从基于超文本的内容演变为动态页面(或称为Hidden Web)数据,后者的数据量约为直接可见页面数据(PIW,Publicly Indexable Web)的400~500%。次。另一方面,多媒体数据、Web Service等各种形式的网络资源日益丰富。因此,基于网页内容的分析算法也从最初的相对简单的文本检索方法发展到综合应用包括网页数据提取、机器学习、数据挖掘、语义理解等多种方法。本节根据网页数据的不同形式,

第一种是针对以文本和超链接为主的非结构化或非常简单的网页;

二是针对结构化数据源(如RDBMS)动态生成的页面,其数据不能直接批量访问;

第三类目标数据介于第一类和第二类数据之间,结构更好,表明它遵循一定的模式或风格,可以直接访问。

分类:

技术要点:

相关文章:

抓取网页音频(视频音频提取器软件安卓最新版更新内容修改功能)

网站优化 • 优采云 发表了文章 • 0 个评论 • 119 次浏览 • 2022-03-12 12:04

安卓最新版视音频提取器软件可以轻松提取视音频文件,支持格式转换,提取的格式也可以自由选择,提取的音频还可以做成手机铃声,还可以分享到社交媒体网站,欢迎朋友们下载使用!

视音频提取器的主要功能

音频提取,可以选择对应的视频,进行转换,得到视频中的音频。

音频界面中的音频可以设置为手机铃声,让你拥有美妙的手机铃声。

视频和音频提取器可以显示本地视频。

音频可以分享给你的朋友,让更多人听到有趣的声音。

视频音频提取器应用程序功能

音频提取:从视频中提取mp3、aac、m4a、m4r、opus等格式;

音频裁剪:从音频中剪切一段以保存或删除一段;

音频调速:调整音频播放速度;

格式转换:将音频文件转换成不同的音乐格式;

调节音量:调节音量,一键操作生成;

音频合并:合并多个音频,一键生成。

使用说明

不仅可以提取音频资源,还可以快速导入图片相关内容,操作更流畅

智能工具可以完全提取所有音频资源不费吹灰之力,手机提取工具非常好用

变更日志

v3.0.0更新

修改重命名功能

v1.0.8更新

支持跳转到解压文件所在的文件夹 查看全部

抓取网页音频(视频音频提取器软件安卓最新版更新内容修改功能)

安卓最新版视音频提取器软件可以轻松提取视音频文件,支持格式转换,提取的格式也可以自由选择,提取的音频还可以做成手机铃声,还可以分享到社交媒体网站,欢迎朋友们下载使用!

视音频提取器的主要功能

音频提取,可以选择对应的视频,进行转换,得到视频中的音频。

音频界面中的音频可以设置为手机铃声,让你拥有美妙的手机铃声。

视频和音频提取器可以显示本地视频。

音频可以分享给你的朋友,让更多人听到有趣的声音。

视频音频提取器应用程序功能

音频提取:从视频中提取mp3、aac、m4a、m4r、opus等格式;

音频裁剪:从音频中剪切一段以保存或删除一段;

音频调速:调整音频播放速度;

格式转换:将音频文件转换成不同的音乐格式;

调节音量:调节音量,一键操作生成;

音频合并:合并多个音频,一键生成。

使用说明

不仅可以提取音频资源,还可以快速导入图片相关内容,操作更流畅

智能工具可以完全提取所有音频资源不费吹灰之力,手机提取工具非常好用

变更日志

v3.0.0更新

修改重命名功能

v1.0.8更新

支持跳转到解压文件所在的文件夹

抓取网页音频(基于目标数据模式的爬虫技术研究综述(一))

网站优化 • 优采云 发表了文章 • 0 个评论 • 39 次浏览 • 2022-03-11 05:21

2 爬虫技术研究综述

基于目标数据模式的爬虫针对网页上的数据,抓取到的数据一般都符合一定的模式,或者可以转化或映射成目标数据模式。

另一种描述方式是构建目标域的本体或字典,用于从语义角度分析主题中不同特征的重要性。

3 网络搜索策略

网页抓取策略可以分为三种类型:深度优先、广度优先和最佳优先。深度优先在很多情况下会导致爬虫被困的问题。目前,广度优先和最佳优先方法很常见。

3.1 广度优先搜索策略

广度优先搜索策略是指在爬取过程中,完成当前一级的搜索后,再进行下一级的搜索。该算法的设计和实现比较简单。目前,为了覆盖尽可能多的网页,一般采用广度优先搜索方式。也有许多研究将广度优先搜索策略应用于聚焦爬虫。其基本思想是距初始 URL 一定链接距离内的网页具有较高的主题相关性概率。另一种方法是将广度优先搜索与网页过滤技术相结合,首先使用广度优先策略抓取网页,然后过滤掉不相关的页面。这些方法的缺点是随着爬取的网页数量的增加,大量无关的网页会被下载过滤,算法效率会变低。

3.2 最优优先级搜索策略

最佳优先级搜索策略是根据一定的网页分析算法预测候选URL与目标网页的相似度,或与主题的相关度,选择评价最好的一个或几个URL进行爬取。它只访问页面分析算法预测为“有用”的页面。一个问题是爬虫爬取路径上的许多相关网页可能会被忽略,因为最佳优先策略是局部最优搜索算法。因此,需要将最佳优先级与具体应用结合起来进行改进,从而跳出局部最优点。在第 4 节中,将结合网页分析算法进行详细讨论。研究表明,这样的闭环调整可以将不相关页面的数量减少 30% 到 90%。

4 网页分析算法

网页分析算法可以分为三类:基于网络拓扑、基于网页内容和基于用户访问行为。

4.1 基于网络拓扑的分析算法

基于网页之间的链接,通过已知的网页或数据,评估与其有直接或间接链接关系的对象(可以是网页或网站等)的算法。进一步分为三种:网页粒度、网站粒度和网页块粒度。

4.1.1 网页粒度分析算法

PageRank 和 HITS 算法是最常见的链接分析算法。两者都是通过网页间链接度的递归归一化计算得到每个网页的重要性。PageRank算法虽然考虑了用户访问行为的随机性和Sink网页的存在性,但忽略了大部分用户访问的目的性,即网页与查询主题链接的相关性。针对这个问题,HITS算法提出了两个关键概念:权威和枢纽。

基于链接的爬取问题是相关页面的主题组之间的隧道现象,即爬取路径上很多离题的页面也指向目标页面,局部评价策略中断了爬取行为当前路径。参考文献[21]提出了一种基于反向链接(BackLink)的层次上下文模型(Context Model),用于将目标网页一定物理跳半径内的网页拓扑图的中心Layer 0描述为目标网页。网页根据指向目标网页的物理跳数进行层次划分,外层网页到内层网页的链接称为反向链接。

4.1.2 网站粒度分析算法

网站粒度资源发现和管理策略也比网页粒度更简单有效。网站粒度爬取的关键是站点的划分和SiteRank的计算。SiteRank的计算方法与PageRank类似,但需要对网站之间的链接进行一定程度的抽象,并在一定的模型下计算链接的权重。

网站划分分为两种:按域名划分和按IP地址划分。参考文献[18]讨论了在分布式情况下,通过划分同一域名下不同主机和服务器的IP地址,构建站点地图,并采用类似于PageRank的方法评估SiteRank。同时,根据每个站点不同文件的分布情况,构建文档图,结合SiteRank分布式计算得到DocRank。参考文献[18]证明,使用分布式SiteRank计算不仅大大降低了单个站点的算法成本,而且克服了单个站点对全网覆盖范围有限的缺点。一个额外的好处是,常见的 PageRank 欺诈很难欺骗 SiteRank。

4.1.3 网页块粒度分析算法

一个页面通常收录多个指向其他页面的链接,而这些链接中只有一部分指向与主题相关的网页,或者根据网页的链接锚文本表明其重要性高。但是在PageRank和HITS算法中,这些链接是没有区分的,所以往往会给网页分析带来广告等噪声链接的干扰。块级链接分析算法的基本思想是通过VIPS网页切分算法将网页分成不同的页面块,然后为这些网页块创建page-to-block和block-block。to-page的链接矩阵分别表示为Z和X。因此,page-to-page图上的page block level的PageRank为Wp=X×Z; 在块到块图上的 BlockRank 是 Wb=Z×X。有人实现了块级PageRank和HITS算法,实验证明效率和准确率优于传统的对应算法。

4.2 基于网页内容的网页分析算法

基于网页内容的分析算法是指利用网页内容的特征(文本、数据等资源)对网页进行评价。网页内容已经从基于超文本的内容演变为动态页面(或称为隐藏网页)数据。后者的数据量约为直接可见页面数据(PIW,Publicly Indexable Web)的400~500倍。次。另一方面,多媒体数据、Web Service等各种形式的网络资源日益丰富。因此,基于网页内容的分析算法也从原来比较简单的文本检索方法发展到网页数据提取、机器学习、数据挖掘、语义理解等多种方法的综合应用。在这个部分,根据网页数据的不同形式,基于网页内容的分析算法分为以下三类:一类是针对以文本和超链接为主的非结构化或非常简单的网页;二是对于结构化和数据源(如RDBMS)动态生成的页面的数据,不能直接批量访问;第三类数据介于第一类数据和第二类数据之间,结构较好,具有一定的模式或风格。并且可以直接访问。 二是对于结构化和数据源(如RDBMS)动态生成的页面的数据,不能直接批量访问;第三类数据介于第一类数据和第二类数据之间,结构较好,具有一定的模式或风格。并且可以直接访问。 二是对于结构化和数据源(如RDBMS)动态生成的页面的数据,不能直接批量访问;第三类数据介于第一类数据和第二类数据之间,结构较好,具有一定的模式或风格。并且可以直接访问。

4.2.1 基于文本的网页分析算法

1) 纯文本分类和聚类算法

它在很大程度上借鉴了文本检索的技术。文本分析算法可以快速有效地对网页进行分类和聚类,但很少单独使用,因为它们忽略了网页之间和网页内的结构信息。

2) 超文本分类和聚类算法

【 dsds4262大作中提到(dsds4262): 】

: 什么是爬虫软件?我不明白

--

你把我带回了一个人,我们变成了世界

没有你的陌生人

原来我的一部分在未来会曲折

被困在灵魂深处,每个人都有自己的悲伤

※ 来源:·北京邮报人物论坛·[FROM: 59.64.195.*] 查看全部

抓取网页音频(基于目标数据模式的爬虫技术研究综述(一))

2 爬虫技术研究综述

基于目标数据模式的爬虫针对网页上的数据,抓取到的数据一般都符合一定的模式,或者可以转化或映射成目标数据模式。

另一种描述方式是构建目标域的本体或字典,用于从语义角度分析主题中不同特征的重要性。

3 网络搜索策略

网页抓取策略可以分为三种类型:深度优先、广度优先和最佳优先。深度优先在很多情况下会导致爬虫被困的问题。目前,广度优先和最佳优先方法很常见。

3.1 广度优先搜索策略

广度优先搜索策略是指在爬取过程中,完成当前一级的搜索后,再进行下一级的搜索。该算法的设计和实现比较简单。目前,为了覆盖尽可能多的网页,一般采用广度优先搜索方式。也有许多研究将广度优先搜索策略应用于聚焦爬虫。其基本思想是距初始 URL 一定链接距离内的网页具有较高的主题相关性概率。另一种方法是将广度优先搜索与网页过滤技术相结合,首先使用广度优先策略抓取网页,然后过滤掉不相关的页面。这些方法的缺点是随着爬取的网页数量的增加,大量无关的网页会被下载过滤,算法效率会变低。

3.2 最优优先级搜索策略

最佳优先级搜索策略是根据一定的网页分析算法预测候选URL与目标网页的相似度,或与主题的相关度,选择评价最好的一个或几个URL进行爬取。它只访问页面分析算法预测为“有用”的页面。一个问题是爬虫爬取路径上的许多相关网页可能会被忽略,因为最佳优先策略是局部最优搜索算法。因此,需要将最佳优先级与具体应用结合起来进行改进,从而跳出局部最优点。在第 4 节中,将结合网页分析算法进行详细讨论。研究表明,这样的闭环调整可以将不相关页面的数量减少 30% 到 90%。

4 网页分析算法

网页分析算法可以分为三类:基于网络拓扑、基于网页内容和基于用户访问行为。

4.1 基于网络拓扑的分析算法

基于网页之间的链接,通过已知的网页或数据,评估与其有直接或间接链接关系的对象(可以是网页或网站等)的算法。进一步分为三种:网页粒度、网站粒度和网页块粒度。

4.1.1 网页粒度分析算法

PageRank 和 HITS 算法是最常见的链接分析算法。两者都是通过网页间链接度的递归归一化计算得到每个网页的重要性。PageRank算法虽然考虑了用户访问行为的随机性和Sink网页的存在性,但忽略了大部分用户访问的目的性,即网页与查询主题链接的相关性。针对这个问题,HITS算法提出了两个关键概念:权威和枢纽。

基于链接的爬取问题是相关页面的主题组之间的隧道现象,即爬取路径上很多离题的页面也指向目标页面,局部评价策略中断了爬取行为当前路径。参考文献[21]提出了一种基于反向链接(BackLink)的层次上下文模型(Context Model),用于将目标网页一定物理跳半径内的网页拓扑图的中心Layer 0描述为目标网页。网页根据指向目标网页的物理跳数进行层次划分,外层网页到内层网页的链接称为反向链接。

4.1.2 网站粒度分析算法

网站粒度资源发现和管理策略也比网页粒度更简单有效。网站粒度爬取的关键是站点的划分和SiteRank的计算。SiteRank的计算方法与PageRank类似,但需要对网站之间的链接进行一定程度的抽象,并在一定的模型下计算链接的权重。

网站划分分为两种:按域名划分和按IP地址划分。参考文献[18]讨论了在分布式情况下,通过划分同一域名下不同主机和服务器的IP地址,构建站点地图,并采用类似于PageRank的方法评估SiteRank。同时,根据每个站点不同文件的分布情况,构建文档图,结合SiteRank分布式计算得到DocRank。参考文献[18]证明,使用分布式SiteRank计算不仅大大降低了单个站点的算法成本,而且克服了单个站点对全网覆盖范围有限的缺点。一个额外的好处是,常见的 PageRank 欺诈很难欺骗 SiteRank。

4.1.3 网页块粒度分析算法

一个页面通常收录多个指向其他页面的链接,而这些链接中只有一部分指向与主题相关的网页,或者根据网页的链接锚文本表明其重要性高。但是在PageRank和HITS算法中,这些链接是没有区分的,所以往往会给网页分析带来广告等噪声链接的干扰。块级链接分析算法的基本思想是通过VIPS网页切分算法将网页分成不同的页面块,然后为这些网页块创建page-to-block和block-block。to-page的链接矩阵分别表示为Z和X。因此,page-to-page图上的page block level的PageRank为Wp=X×Z; 在块到块图上的 BlockRank 是 Wb=Z×X。有人实现了块级PageRank和HITS算法,实验证明效率和准确率优于传统的对应算法。

4.2 基于网页内容的网页分析算法

基于网页内容的分析算法是指利用网页内容的特征(文本、数据等资源)对网页进行评价。网页内容已经从基于超文本的内容演变为动态页面(或称为隐藏网页)数据。后者的数据量约为直接可见页面数据(PIW,Publicly Indexable Web)的400~500倍。次。另一方面,多媒体数据、Web Service等各种形式的网络资源日益丰富。因此,基于网页内容的分析算法也从原来比较简单的文本检索方法发展到网页数据提取、机器学习、数据挖掘、语义理解等多种方法的综合应用。在这个部分,根据网页数据的不同形式,基于网页内容的分析算法分为以下三类:一类是针对以文本和超链接为主的非结构化或非常简单的网页;二是对于结构化和数据源(如RDBMS)动态生成的页面的数据,不能直接批量访问;第三类数据介于第一类数据和第二类数据之间,结构较好,具有一定的模式或风格。并且可以直接访问。 二是对于结构化和数据源(如RDBMS)动态生成的页面的数据,不能直接批量访问;第三类数据介于第一类数据和第二类数据之间,结构较好,具有一定的模式或风格。并且可以直接访问。 二是对于结构化和数据源(如RDBMS)动态生成的页面的数据,不能直接批量访问;第三类数据介于第一类数据和第二类数据之间,结构较好,具有一定的模式或风格。并且可以直接访问。

4.2.1 基于文本的网页分析算法

1) 纯文本分类和聚类算法

它在很大程度上借鉴了文本检索的技术。文本分析算法可以快速有效地对网页进行分类和聚类,但很少单独使用,因为它们忽略了网页之间和网页内的结构信息。

2) 超文本分类和聚类算法

【 dsds4262大作中提到(dsds4262): 】

: 什么是爬虫软件?我不明白

--

你把我带回了一个人,我们变成了世界

没有你的陌生人

原来我的一部分在未来会曲折

被困在灵魂深处,每个人都有自己的悲伤

※ 来源:·北京邮报人物论坛·[FROM: 59.64.195.*]

抓取网页音频((SearchEngine)通用搜索引擎的自动提取网页的程序,聚焦爬虫)

网站优化 • 优采云 发表了文章 • 0 个评论 • 88 次浏览 • 2022-03-11 05:20

网络爬虫是一个功能强大的程序,可以自动提取网页。它为搜索引擎从万维网上下载网页,是搜索引擎的重要组成部分。

聚焦爬虫 随着网络的飞速发展,万维网已经成为大量信息的载体,如何有效地提取和利用这些信息成为了巨大的挑战。

搜索引擎(SearchEngine),如传统的通用搜索引擎AltaVista、Yahoo!

而谷歌等,作为辅助人们检索信息的工具,已经成为用户访问万维网的门户和指南。

但是,这些通用搜索引擎也有一定的局限性,例如:

专注于爬虫

(1)不同领域、不同背景的用户往往有不同的检索目的和需求,一般搜索引擎返回的结果收录大量用户不关心的网页。

(2)通用搜索引擎的目标是最大化网络覆盖,有限的搜索引擎服务器资源与无限的网络数据资源之间的冲突将进一步加深。

(3)万维网数据形式的丰富和网络技术的不断发展,图片、数据库、音频、视频、多媒体等不同的数据大量出现,一般的搜索引擎往往无能为力对这些信息内容密集、具有一定结构的数据,无能为力。很好的发现和获取。

(4)一般搜索引擎大多提供基于关键词的检索,难以支持基于语义信息的查询。

聚焦爬虫为了解决以上问题,定向爬取相关网页资源的聚焦爬虫应运而生。

聚焦爬虫是一种自动下载网页的程序。它根据给定的爬取目标有选择地访问万维网上的网页和相关链接,以获取所需的信息。

与通用网络爬虫不同,聚焦爬虫不追求大覆盖,而是旨在爬取与特定主题内容相关的网页,并为面向主题的用户查询准备数据资源。

垂直搜索的本质是从主题相关领域获取和处理与搜索行为相匹配的结构化数据和元数据信息。

如数码产品mp3:

内存、大小、规格、电池型号、价格、厂家等,也可提供比价服务。爬虫基本原理 网络爬虫通过网页的链接地址搜索网页,从一个或多个初始网页的URL(通常是某个网站首页)开始,遍历网页空间,阅读网页的内容,不断地从一个站点移动到另一个站点,并自动建立索引。

在抓取网页的过程中,找到网页中的其他链接地址,解析HTML文件,取出页面中的子链接,加入网页数据库,不断从当前提取新的URL页面并将它们放入队列中。,以此类推,直到这个网站的所有网页都被爬取完毕,并且满足系统的一定停止条件。

爬虫的基本原理 此外,所有被爬虫爬取的网页都会被系统存储,经过一定的分析、过滤、索引,以供后续查询和检索。

当网络爬虫分析一个网页时,它使用 HTML 语言的标记结构来获取指向其他网页的 URL 地址,这可以完全独立于用户干预。

如果把整个互联网看成一个网站,理论上网络爬虫可以爬取互联网上的所有网页。对后续抓取过程给予反馈和指导。

正是这种行为使这些程序被称为蜘蛛、爬虫、机器人。

爬虫基础知识 Spider 如何爬取所有网页?在 Web 出现之前,传统的文本集合,例如目录数据库和期刊摘要,被存储在磁带或 CD-ROM 上并用作索引系统。

相应地,Web 上可访问的所有 URL 都是未分类的,采集 URL 的唯一方法是通过扫描采集到其他尚未采集的页面的超链接。

爬虫的基本原理是从给定的一组 URL 开始,逐步爬取和扫描那些新的外链。

一遍又一遍地抓取这些页面。

这些新发现的 URL 将作为爬虫未来的爬取作业。

随着爬取的进行,这些未来的工作集也会扩展,写入器会将这些数据写入磁盘以释放主内存,避免爬虫崩溃导致数据丢失。

不能保证所有的网页访问都是这样进行的,爬虫永远不会停止,并且页面会在蜘蛛运行的同时不断增加。

页面中收录的文本也将呈现给文本索引器,用于基于 关键词 的信息索引。

工作流网络爬虫是搜索引擎的核心部分。整个搜索引擎的素材库来自网络爬虫的采集。从搜索引擎整个产业链来看,网络爬虫是最上游的产业。

它的性能直接影响搜索引擎的整体性能和处理速度。

一般的网络爬虫从一个或多个初始网页上的URL开始,获取初始网页上的URL列表,在抓取网页的过程中不断从当前页面中提取新的URL放入待抓取队列中直到系统满意为止。停止条件。

工作流网络爬虫的基本架构如图所示,各部分的主要功能描述如下:

1. 页面采集模块:

该模块是爬虫与互联网之间的接口。它的主要功能是通过各种web协议(一般是HTTP)完成网页数据的采集。由后续模块进一步处理。

该过程类似于用户使用浏览器打开网页,保存的网页由其他后续模块处理,例如页面分析和链接提取。

工作流程2.页面分析模块:

该模块的主要功能是从页面采集module采集中分析页面,提取出符合用户要求的超链接,加入超链接队列。

页面链接中给出的URL一般有多种格式,可以是收录协议、站点和路径的完整的,也可以是省略的部分内容,也可以是相对路径。

因此,为了处理的方便,一般都会进行归一化处理,先转换成统一的格式。

工作流程3、链接过滤器模块:

该模块主要用于过滤重复链接和循环链接。

例如,相对路径需要补全 URL,然后将它们添加到 URL 队列中为 采集。

此时,队列中已经收录的URL和循环链接的URL一般都会被过滤掉。

工作流程 4. 页库:

用于存储已经 采集 进行后期处理的页面。

5. 待处理的 采集URL 队列:

从 采集 网页中提取的 URL 并进行相应处理。当 URL 为空时,爬虫终止。

6. 初始网址:

提供 URL 种子启动爬虫关键技术分析 爬取目标定义和网页 URL Search 的搜索策略描述,爬取目标网页,然后从中提取所需的结构化信息。

稳定性和数量上乘,但成本高,性活动差。

根据目标网页上结构化数据对应的模板级垂直搜索,直接解析页面,提取结构化数据信息并进行处理。

实施速度快,成本低,灵活性高,但后期维护成本高。

URL 搜索策略 网络爬虫 URL 爬取策略有:

IP地址搜索策略 广度优先 深度优先 最佳优先级 URL搜索策略 基于IP地址的搜索策略首先给爬虫分配一个起始IP地址,然后根据递增的IP搜索该端口地址段之后的每个WWW地址地址文档,它根本不考虑每个文档中指向其他网站的超链接地址。

优点是搜索全面,可以找到其他文档没有引用的新文档的信息来源。缺点是不适合大规模的 URL 搜索。搜索完成后,进行下一级搜索。

这样逐层搜索,以此类推。

该算法的设计和实现比较简单。

目前,为了覆盖尽可能多的网页,一般采用广度优先搜索方式。

许多研究人员已将广度优先搜索策略应用于主题爬虫。

他们认为距原创 URL 一定链接距离内的网页具有很高的主题相关性。

URL搜索策略的另一种方法是将广度优先搜索与网页过滤技术相结合,首先使用广度优先策略抓取网页,然后过滤掉不相关的网页。

这些方法的缺点是随着爬取的网页数量的增加,会下载和过滤大量不相关的网页,算法的效率会变低。

使用广度优先策略的爬取顺序为:

AB、C、D、E、FG、HI。

URL 搜索策略 深度优先搜索策略 深度优先搜索是早期开发网络爬虫时使用较多的方法之一,目的是到达叶子节点,即那些不收录任何超链接的页面文件。

Starting from the start page in the current HTML file, when a hyperlink is selected, the linked HTML file will perform a depth-first search, follow each link one link at a time, and go to the next start after processing this line. 页面,继续关注链接。

也就是说,在搜索剩余的超链结果之前,必须先完整搜索一条链。

URL 深度优先搜索的搜索策略是沿着 HTML 文档上的超链接到不能再往前走的地方,然后返回到某个 HTML 文档,然后继续选择 HTML 文档中的其他超链接。

当没有其他超链接可供选择时,搜索结束。

这种方法的一个优点是网络蜘蛛更容易设计。

使用深度优先策略的爬取顺序为:

AFG、EHI、B、C、D。

如今,广度优先和最佳优先的方法很常见。

URL搜索策略 最佳优先搜索策略 最佳优先搜索策略 根据一定的网页分析算法,首先计算目标网页与URL描述文本的相似度,设置一个值,选择一个或多个超过该值的评价分数. 要抓取的 URL。

它只访问网页分析算法计算出的相关性大于给定值的网页。

一个问题是爬虫爬取路径上的许多相关网页可能会被忽略,因为最佳优先策略是局部最优搜索算法。

因此,需要将最佳优先级与具体应用结合起来进行改进,从而跳出局部最优点。

研究表明,这样的闭环调整可以将不相关网页的数量减少30%--90%。

网页分析与信息提取 基于网络拓扑关系的分析算法是根据页面间的超链接引用关系,对与已知网页直接或间接相关的对象进行评估的算法。

网页粒度PageRank,网站粒度SiteRank。

基于网页内容的分析算法已经从最初的文本检索方法发展到涉及网页数据提取、机器学习、数据挖掘、自然语言等多个领域的综合方向。

基于用户访问行为的代表性分析算法是基于领域概念的分析算法,其中涉及到本体。

示例显示,简要分析页面源码定位的爬取目标是娱乐博文,所以在首页源码中搜索“娱乐”后,发现如下字段:

家庭娱乐解析html实现网页爬虫,顾名思义,需要另外一个程序来自动解析网页。

考虑到垂直爬虫和站内搜索的重要性,在处理页面时,需要强大的HTMLXMLParser来支持解析。只有对目标文件进行格式化,才能实现特定信息的提取、特定信息的删除和遍历。操作。

HTMLParser,这是 Python 用来解析 HTML 的模块。

它可以分析HTML中的标签、数据等,是处理HTML的一种简便方法。 查看全部

抓取网页音频((SearchEngine)通用搜索引擎的自动提取网页的程序,聚焦爬虫)

网络爬虫是一个功能强大的程序,可以自动提取网页。它为搜索引擎从万维网上下载网页,是搜索引擎的重要组成部分。

聚焦爬虫 随着网络的飞速发展,万维网已经成为大量信息的载体,如何有效地提取和利用这些信息成为了巨大的挑战。

搜索引擎(SearchEngine),如传统的通用搜索引擎AltaVista、Yahoo!

而谷歌等,作为辅助人们检索信息的工具,已经成为用户访问万维网的门户和指南。

但是,这些通用搜索引擎也有一定的局限性,例如:

专注于爬虫

(1)不同领域、不同背景的用户往往有不同的检索目的和需求,一般搜索引擎返回的结果收录大量用户不关心的网页。

(2)通用搜索引擎的目标是最大化网络覆盖,有限的搜索引擎服务器资源与无限的网络数据资源之间的冲突将进一步加深。

(3)万维网数据形式的丰富和网络技术的不断发展,图片、数据库、音频、视频、多媒体等不同的数据大量出现,一般的搜索引擎往往无能为力对这些信息内容密集、具有一定结构的数据,无能为力。很好的发现和获取。

(4)一般搜索引擎大多提供基于关键词的检索,难以支持基于语义信息的查询。

聚焦爬虫为了解决以上问题,定向爬取相关网页资源的聚焦爬虫应运而生。

聚焦爬虫是一种自动下载网页的程序。它根据给定的爬取目标有选择地访问万维网上的网页和相关链接,以获取所需的信息。

与通用网络爬虫不同,聚焦爬虫不追求大覆盖,而是旨在爬取与特定主题内容相关的网页,并为面向主题的用户查询准备数据资源。

垂直搜索的本质是从主题相关领域获取和处理与搜索行为相匹配的结构化数据和元数据信息。

如数码产品mp3:

内存、大小、规格、电池型号、价格、厂家等,也可提供比价服务。爬虫基本原理 网络爬虫通过网页的链接地址搜索网页,从一个或多个初始网页的URL(通常是某个网站首页)开始,遍历网页空间,阅读网页的内容,不断地从一个站点移动到另一个站点,并自动建立索引。

在抓取网页的过程中,找到网页中的其他链接地址,解析HTML文件,取出页面中的子链接,加入网页数据库,不断从当前提取新的URL页面并将它们放入队列中。,以此类推,直到这个网站的所有网页都被爬取完毕,并且满足系统的一定停止条件。

爬虫的基本原理 此外,所有被爬虫爬取的网页都会被系统存储,经过一定的分析、过滤、索引,以供后续查询和检索。

当网络爬虫分析一个网页时,它使用 HTML 语言的标记结构来获取指向其他网页的 URL 地址,这可以完全独立于用户干预。

如果把整个互联网看成一个网站,理论上网络爬虫可以爬取互联网上的所有网页。对后续抓取过程给予反馈和指导。

正是这种行为使这些程序被称为蜘蛛、爬虫、机器人。

爬虫基础知识 Spider 如何爬取所有网页?在 Web 出现之前,传统的文本集合,例如目录数据库和期刊摘要,被存储在磁带或 CD-ROM 上并用作索引系统。

相应地,Web 上可访问的所有 URL 都是未分类的,采集 URL 的唯一方法是通过扫描采集到其他尚未采集的页面的超链接。

爬虫的基本原理是从给定的一组 URL 开始,逐步爬取和扫描那些新的外链。

一遍又一遍地抓取这些页面。

这些新发现的 URL 将作为爬虫未来的爬取作业。

随着爬取的进行,这些未来的工作集也会扩展,写入器会将这些数据写入磁盘以释放主内存,避免爬虫崩溃导致数据丢失。

不能保证所有的网页访问都是这样进行的,爬虫永远不会停止,并且页面会在蜘蛛运行的同时不断增加。

页面中收录的文本也将呈现给文本索引器,用于基于 关键词 的信息索引。

工作流网络爬虫是搜索引擎的核心部分。整个搜索引擎的素材库来自网络爬虫的采集。从搜索引擎整个产业链来看,网络爬虫是最上游的产业。

它的性能直接影响搜索引擎的整体性能和处理速度。

一般的网络爬虫从一个或多个初始网页上的URL开始,获取初始网页上的URL列表,在抓取网页的过程中不断从当前页面中提取新的URL放入待抓取队列中直到系统满意为止。停止条件。

工作流网络爬虫的基本架构如图所示,各部分的主要功能描述如下:

1. 页面采集模块:

该模块是爬虫与互联网之间的接口。它的主要功能是通过各种web协议(一般是HTTP)完成网页数据的采集。由后续模块进一步处理。

该过程类似于用户使用浏览器打开网页,保存的网页由其他后续模块处理,例如页面分析和链接提取。

工作流程2.页面分析模块:

该模块的主要功能是从页面采集module采集中分析页面,提取出符合用户要求的超链接,加入超链接队列。

页面链接中给出的URL一般有多种格式,可以是收录协议、站点和路径的完整的,也可以是省略的部分内容,也可以是相对路径。

因此,为了处理的方便,一般都会进行归一化处理,先转换成统一的格式。

工作流程3、链接过滤器模块:

该模块主要用于过滤重复链接和循环链接。

例如,相对路径需要补全 URL,然后将它们添加到 URL 队列中为 采集。

此时,队列中已经收录的URL和循环链接的URL一般都会被过滤掉。

工作流程 4. 页库:

用于存储已经 采集 进行后期处理的页面。

5. 待处理的 采集URL 队列:

从 采集 网页中提取的 URL 并进行相应处理。当 URL 为空时,爬虫终止。

6. 初始网址:

提供 URL 种子启动爬虫关键技术分析 爬取目标定义和网页 URL Search 的搜索策略描述,爬取目标网页,然后从中提取所需的结构化信息。

稳定性和数量上乘,但成本高,性活动差。

根据目标网页上结构化数据对应的模板级垂直搜索,直接解析页面,提取结构化数据信息并进行处理。

实施速度快,成本低,灵活性高,但后期维护成本高。

URL 搜索策略 网络爬虫 URL 爬取策略有:

IP地址搜索策略 广度优先 深度优先 最佳优先级 URL搜索策略 基于IP地址的搜索策略首先给爬虫分配一个起始IP地址,然后根据递增的IP搜索该端口地址段之后的每个WWW地址地址文档,它根本不考虑每个文档中指向其他网站的超链接地址。

优点是搜索全面,可以找到其他文档没有引用的新文档的信息来源。缺点是不适合大规模的 URL 搜索。搜索完成后,进行下一级搜索。

这样逐层搜索,以此类推。

该算法的设计和实现比较简单。

目前,为了覆盖尽可能多的网页,一般采用广度优先搜索方式。

许多研究人员已将广度优先搜索策略应用于主题爬虫。

他们认为距原创 URL 一定链接距离内的网页具有很高的主题相关性。

URL搜索策略的另一种方法是将广度优先搜索与网页过滤技术相结合,首先使用广度优先策略抓取网页,然后过滤掉不相关的网页。

这些方法的缺点是随着爬取的网页数量的增加,会下载和过滤大量不相关的网页,算法的效率会变低。

使用广度优先策略的爬取顺序为:

AB、C、D、E、FG、HI。

URL 搜索策略 深度优先搜索策略 深度优先搜索是早期开发网络爬虫时使用较多的方法之一,目的是到达叶子节点,即那些不收录任何超链接的页面文件。

Starting from the start page in the current HTML file, when a hyperlink is selected, the linked HTML file will perform a depth-first search, follow each link one link at a time, and go to the next start after processing this line. 页面,继续关注链接。

也就是说,在搜索剩余的超链结果之前,必须先完整搜索一条链。

URL 深度优先搜索的搜索策略是沿着 HTML 文档上的超链接到不能再往前走的地方,然后返回到某个 HTML 文档,然后继续选择 HTML 文档中的其他超链接。

当没有其他超链接可供选择时,搜索结束。

这种方法的一个优点是网络蜘蛛更容易设计。

使用深度优先策略的爬取顺序为:

AFG、EHI、B、C、D。

如今,广度优先和最佳优先的方法很常见。

URL搜索策略 最佳优先搜索策略 最佳优先搜索策略 根据一定的网页分析算法,首先计算目标网页与URL描述文本的相似度,设置一个值,选择一个或多个超过该值的评价分数. 要抓取的 URL。

它只访问网页分析算法计算出的相关性大于给定值的网页。

一个问题是爬虫爬取路径上的许多相关网页可能会被忽略,因为最佳优先策略是局部最优搜索算法。

因此,需要将最佳优先级与具体应用结合起来进行改进,从而跳出局部最优点。

研究表明,这样的闭环调整可以将不相关网页的数量减少30%--90%。

网页分析与信息提取 基于网络拓扑关系的分析算法是根据页面间的超链接引用关系,对与已知网页直接或间接相关的对象进行评估的算法。

网页粒度PageRank,网站粒度SiteRank。

基于网页内容的分析算法已经从最初的文本检索方法发展到涉及网页数据提取、机器学习、数据挖掘、自然语言等多个领域的综合方向。

基于用户访问行为的代表性分析算法是基于领域概念的分析算法,其中涉及到本体。

示例显示,简要分析页面源码定位的爬取目标是娱乐博文,所以在首页源码中搜索“娱乐”后,发现如下字段:

家庭娱乐解析html实现网页爬虫,顾名思义,需要另外一个程序来自动解析网页。

考虑到垂直爬虫和站内搜索的重要性,在处理页面时,需要强大的HTMLXMLParser来支持解析。只有对目标文件进行格式化,才能实现特定信息的提取、特定信息的删除和遍历。操作。

HTMLParser,这是 Python 用来解析 HTML 的模块。

它可以分析HTML中的标签、数据等,是处理HTML的一种简便方法。

抓取网页音频(浏览器获取录音的创建实例启动录音实例上有个state状态)

网站优化 • 优采云 发表了文章 • 0 个评论 • 68 次浏览 • 2022-03-11 05:19

一、整体实现的思路

页面录制的实现需要使用浏览器提供的MediaRecorder API,所以要实现页面录制,浏览器需要支持MediaStream Recording相关的功能,即浏览器可以获得浏览器的录制权限.

页面内容需要一个按钮来记录录音的开始和结束,以及一个播放录音的标签,然后设计具体的实现细节:首先,我们需要确定浏览器在进入页面时是否支持该API,如果是,则获取浏览器。获得权限后,我们的页面上分别有录制按钮和音频标签audio,然后我们需要设计在点击录制按钮时开始录制音频的逻辑(这一步的前提是我们需要创建 Recording 实例),然后开始录制和结束录制。录音结束后,我们把获取到的录音实例放到音频中,点击播放,就可以播放录音了。

二、详情及功能

浏览器访问录制权限

/*获取浏览器的录音权限,contraint是需要获取权限的列表*/

const constraints = { audio: true };

//返回的是Promise对象,因为需要等到用户确定授予权限的时候,我们才会处理下面的步骤,navigator是浏览器对象,我们就是通过navigator获取录音权限,成功回调的话就会获取到一个stream,然后将这个stream放入到我们下面创建的录音实例里面去

navigator.mediaDevices.getUserMedia(constraints)

创建录音实例

//通过该方法创建录音实例

var mediaRecorder = new MediaRecorder(stream);

开始录音

//通过点击按钮来启动或者结束录音

//获取按钮节点

const recordBtn = document.querySelector(".record-btn");

//创建录音实例

const mediaRecorder = new MediaRecorder(stream);

recordBtn.onclick = () => {

mediaRecorder.start();

console.log("录音中...");

};

//

MediaRecorder 实例上有一个 state 状态,可以用来判断当前记录器的活动状态。一共有三个值:

inactive:处于静止状态,要么不启动,要么启动后停止。

录音:录音

paused:开始,但暂停,既不停止也不恢复。

//更加完整的录音逻辑

recordBtn.onclick = () => {

if (mediaRecorder.state === "recording") {

mediaRecorder.stop();

recordBtn.textContent = "record";

console.log("录音结束");

} else {

mediaRecorder.start();

console.log("录音中...");

recordBtn.textContent = "stop";

}

console.log("录音器状态:", mediaRecorder.state);

};

音频数据的采集

上面的按钮处理来自用户的交互,只负责开始或停止录制。音频数据也是从 MediaRecorder 实例通过监听其相应事件来完成的。

当录制开始时,它的 MediaRecorder.ondataavailable 事件将被触发。事件回调的入参为BlobEvent,从中获取的event.data就是我们需要的音频数据。因为数据是一块块生成的,所以需要临时存储在一个数组中。

const chunks = [];

mediaRecorder.ondataavailable = function(e) {

chunks.push(e.data);

};

当录制结束播放音频时,通过监听MediaRecorder.onstop事件将采集到的音频数据创建为Blob对象,然后通过URL.createObjectURL创建为html中标签可以使用的资源链接。

mediaRecorder.onstop = e => {

var blob = new Blob(chunks, { type: "audio/ogg; codecs=opus" });

chunks = [];

var audioURL = window.URL.createObjectURL(blob);

audio.src = audioURL;

};

三、详细完整的代码

实现在网页上录音

record

record

if (navigator.mediaDevices.getUserMedia) {

const constraints = { audio: true };

navigator.mediaDevices.getUserMedia(constraints).then(

stream => {

console.log("授权成功!");

const recordBtn = document.querySelector(".record-btn");

const mediaRecorder = new MediaRecorder(stream);

var chunks = [];

recordBtn.onclick = () => {

if (mediaRecorder.state === "recording") {

mediaRecorder.stop();

console.log(chunks)

mediaRecorder.onstop = e => {

var blob= new Blob(chunks, { type: "audio/ogg; codecs=opus" });

chunks = [];

var audioURL = window.URL.createObjectURL(blob);

const audioSrc = document.querySelector(".audio-player");

audioSrc.src = audioURL;

};

recordBtn.textContent = "record";

console.log("录音结束");

} else {

mediaRecorder.start();

mediaRecorder.ondataavailable = function(e) {

chunks.push(e.data);

};

console.log(chunks)

console.log("录音中...");

recordBtn.textContent = "stop";

}

console.log("录音器状态:", mediaRecorder.state);

};

},

() => {

console.error("授权失败!");

}

);

} else {

console.error("浏览器不支持 getUserMedia");

}

if (navigator.mediaDevices.getUserMedia) {

const constraints1 = { audio: true };

navigator.mediaDevices.getUserMedia(constraints1).then(

stream1 => {

console.log("授权成功!");

const recordBtn1 = document.querySelector(".record-btn1");

const mediaRecorder1 = new MediaRecorder(stream1);

var chunks1 = [];

recordBtn1.onclick = () => {

if (mediaRecorder1.state === "recording") {

mediaRecorder1.stop();

//console.log(chunks)

mediaRecorder1.onstop = e => {

var blob1 = new Blob(chunks1, { type: "audio/ogg; codecs=opus" });

chunks1 = [];