抓取网页音频

抓取网页音频(如何最高效地从海量信息里获取数据呢?(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 69 次浏览 • 2021-09-22 01:19

数据已进入各行各业并已被广泛使用,并且它是伴随着应用程序和数据的准确的挖掘。我们可以从内部repositorys和外部的载体,内部数据集成应用更多的数据和外部数据需要第一次。外部数据的最大矢量是因特网。在网页上,我们很难在增量数据,其中收录了我们很多信息,利用价值来算。

如何最有效地获取从海量的信息数据?卷筒纸原料工具@ @优采云采集器有高招,使用自动化的智能工具代替人工数据采集,当然,更有效的是更精确的。

一、数据用的通通

作为一个一般的网络抓取工具,@ @优采云采集器 @@ 采集器 @@ 采集器基操作操作操作操作让让网取网功能,,验证码识别,IP代理等网站采集ķ措;所捕获的对象的格式可以是文本,图片,音频,文件等,不再重复操作,轻松地将数据装入胶囊。

采集器2 @数据数据高的高高

高效是用于数据应用的另一个重要的吸引力,和信息爆炸式增长。如果你不能与速度跟不上,你会错过数据利用的最佳节点,所以它是数据采集的效率非常高。在过去,我们手动@采集数据,一百数据和网络捕获工具稳定在每天10万级,是几百倍的手工@采集。

采集器3 @Derating精度

有关的信息很长的时间可能会产生疲劳,而且软件标识可以继续肉眼辨别出要高精度地提取。然而,应该指出的是,@采集不同类型@ 网站或数据,@ @优采云采集器 @@ 采集器配置规则是不同的,并且可以仅由特定的条件,以保证高精度。

应对大数据时代的呼唤,注重数据资源,充分利用网络的抓取工具,并轻松集成胶囊,实现高利用数据资产和价值的价值! 查看全部

抓取网页音频(如何最高效地从海量信息里获取数据呢?(组图))

数据已进入各行各业并已被广泛使用,并且它是伴随着应用程序和数据的准确的挖掘。我们可以从内部repositorys和外部的载体,内部数据集成应用更多的数据和外部数据需要第一次。外部数据的最大矢量是因特网。在网页上,我们很难在增量数据,其中收录了我们很多信息,利用价值来算。

如何最有效地获取从海量的信息数据?卷筒纸原料工具@ @优采云采集器有高招,使用自动化的智能工具代替人工数据采集,当然,更有效的是更精确的。

一、数据用的通通

作为一个一般的网络抓取工具,@ @优采云采集器 @@ 采集器 @@ 采集器基操作操作操作操作让让网取网功能,,验证码识别,IP代理等网站采集ķ措;所捕获的对象的格式可以是文本,图片,音频,文件等,不再重复操作,轻松地将数据装入胶囊。

采集器2 @数据数据高的高高

高效是用于数据应用的另一个重要的吸引力,和信息爆炸式增长。如果你不能与速度跟不上,你会错过数据利用的最佳节点,所以它是数据采集的效率非常高。在过去,我们手动@采集数据,一百数据和网络捕获工具稳定在每天10万级,是几百倍的手工@采集。

采集器3 @Derating精度

有关的信息很长的时间可能会产生疲劳,而且软件标识可以继续肉眼辨别出要高精度地提取。然而,应该指出的是,@采集不同类型@ 网站或数据,@ @优采云采集器 @@ 采集器配置规则是不同的,并且可以仅由特定的条件,以保证高精度。

应对大数据时代的呼唤,注重数据资源,充分利用网络的抓取工具,并轻松集成胶囊,实现高利用数据资产和价值的价值!

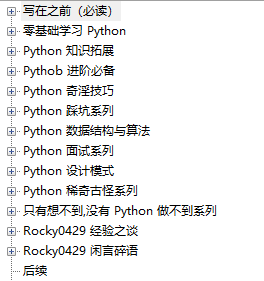

抓取网页音频( Python修炼之道400页17w+字,目录如下! )

网站优化 • 优采云 发表了文章 • 0 个评论 • 79 次浏览 • 2021-09-10 23:13

Python修炼之道400页17w+字,目录如下!

)

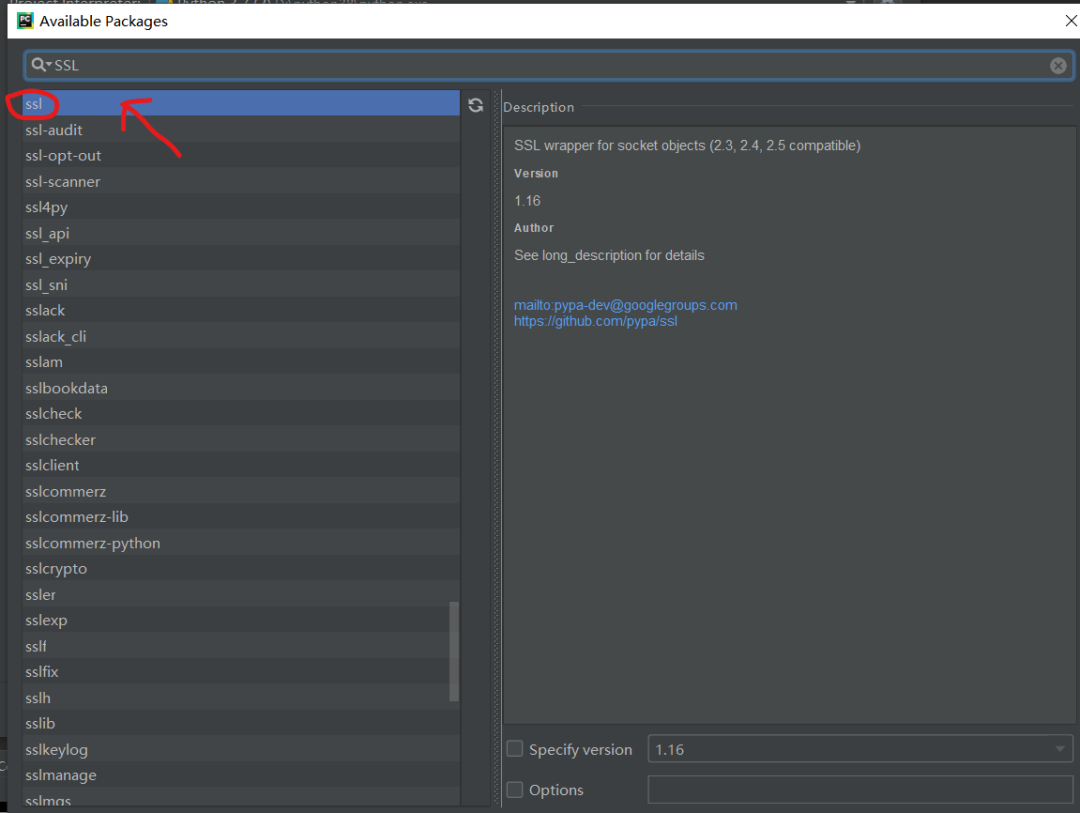

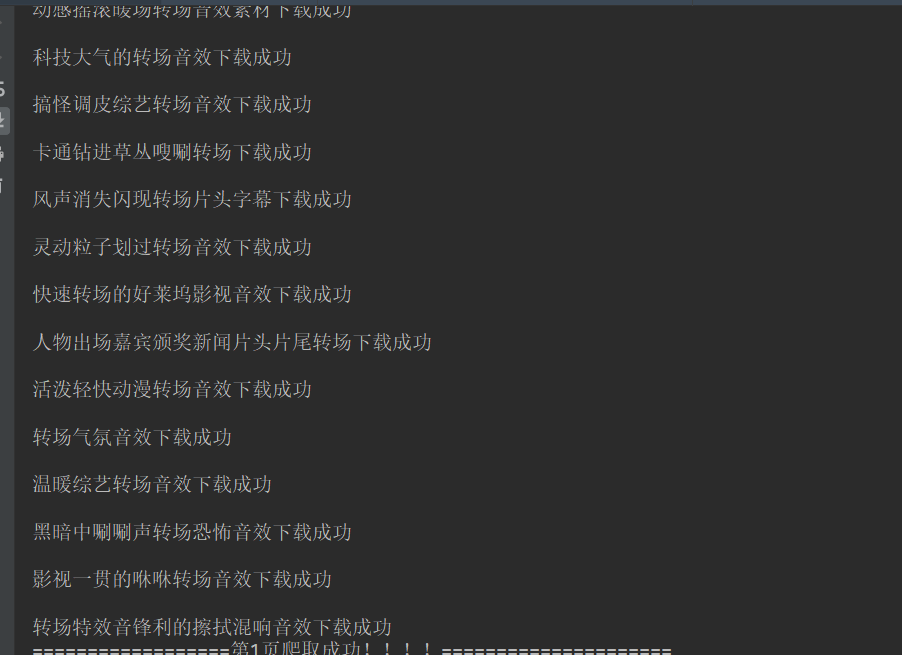

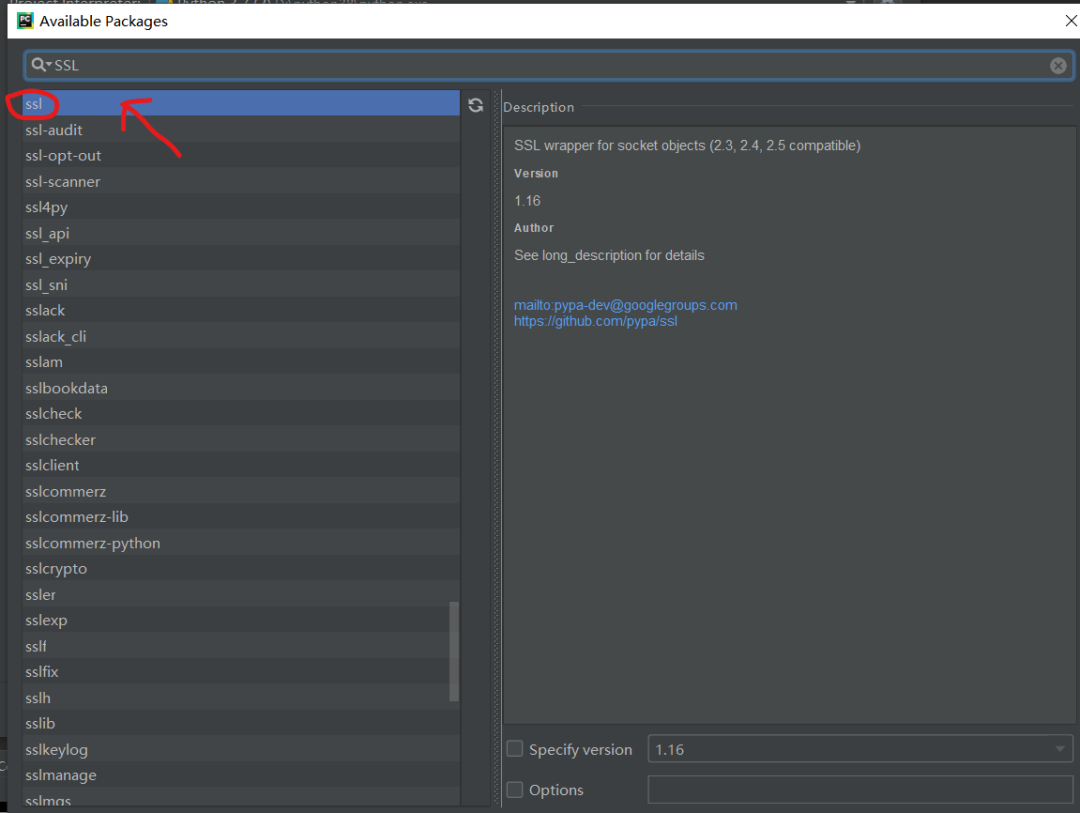

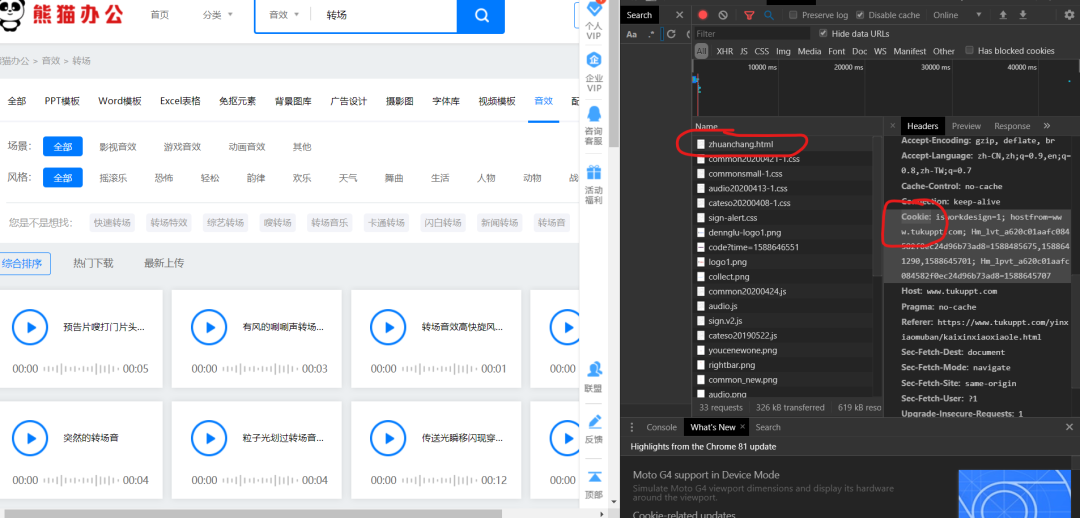

4、如何获取cookies?

右击检查,找到网络,然后复制一个cookie:

/5 项目实现/

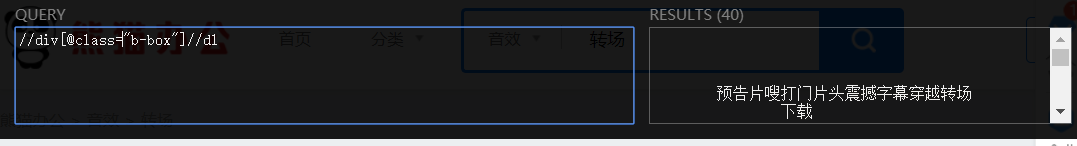

1、定义一个类继承对象,定义init方法继承self,main函数main继承self。导入需要的库和URL,代码如下。

import requestsfrom lxml import etreefrom fake_useragent import UserAgentimport sslclass Panda(object): def __init__(self): pass def main(self): passif __name__ == '__main__': imageSpider = Panda() imageSpider.main()

2、Import URL 并构造请求头。

self.url = "https://www.tukuppt.com/yinxia ... _0_0_{}.html" #/zhuanchang/:搜索的名字的拼音缩写 self.headers = { "User-Agent": "Mozilla/5.0 (Macintosh; Intel Mac OS X 10_11_6) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/70.0.3538.77 Safari/537.36" }

3、发送请求获取响应,页面回调,方便下次请求。

def get_page(self, url): res = requests.get(url=url, headers=self.headers) html = res.content.decode("utf-8") return html

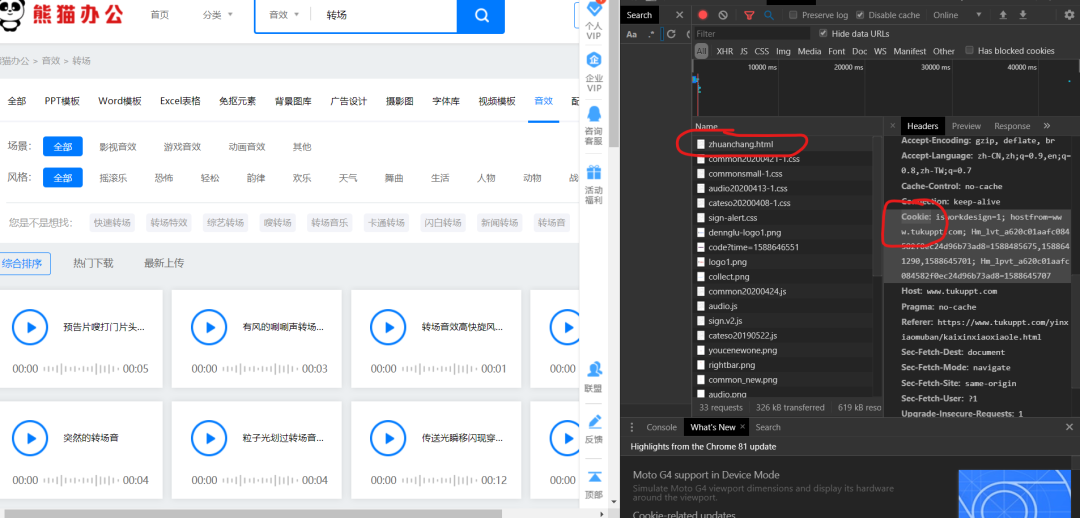

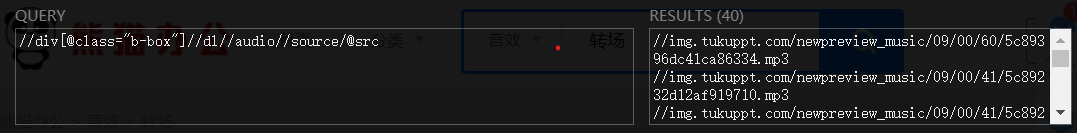

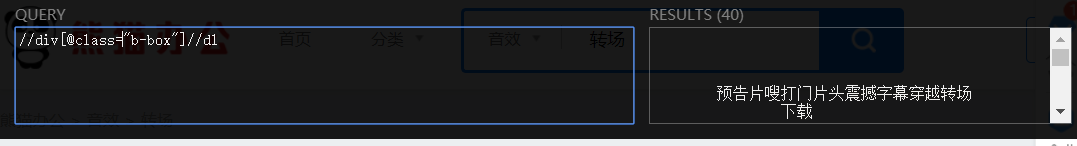

4、xpath 解析页面数据。

这里先获取父节点,通过for循环遍历找到对应的子节点(音效地址)。

one = parse_html.xpath('//div[@]//dl') for li in one: lis_imges = li.xpath(".//audio//source/@src")[0].strip() who = li.xpath(".//dt//a/text()")[0].strip()

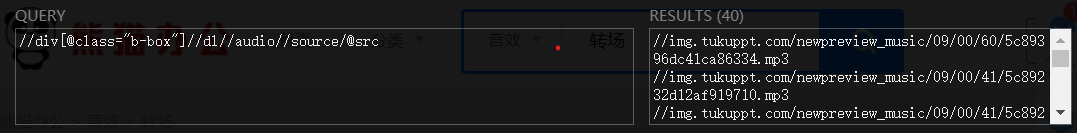

获取后发现地址代表完整地址,需要填写网站才能获取实际地址。

mp3 = "https:" + lis_imges

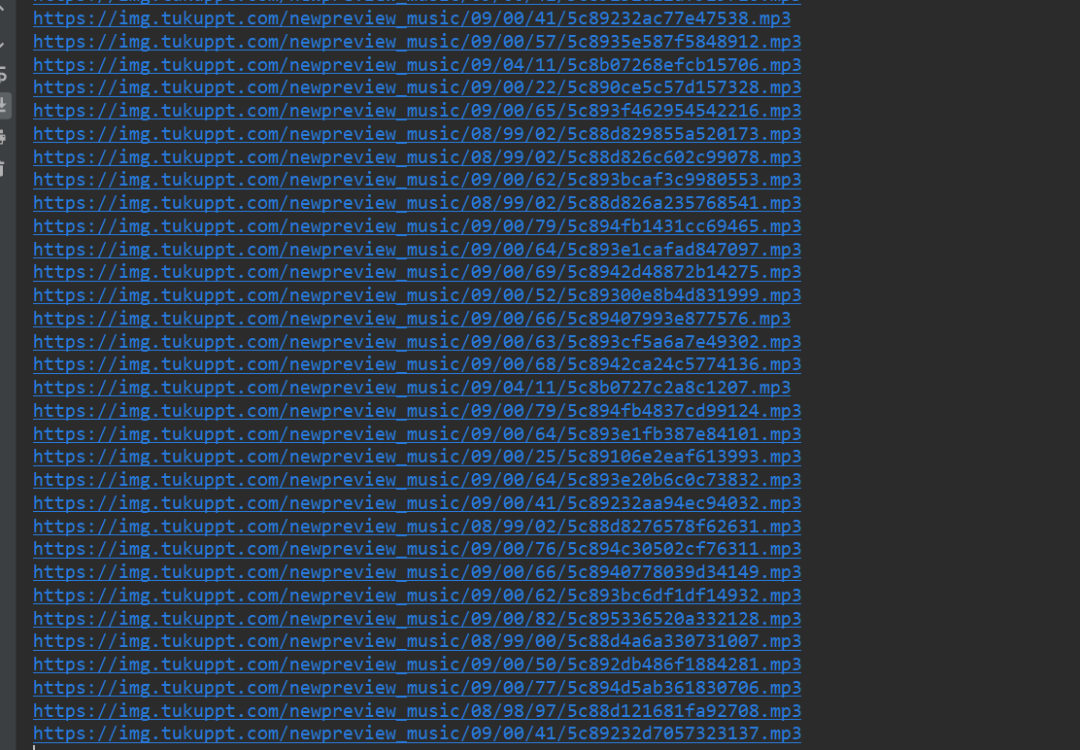

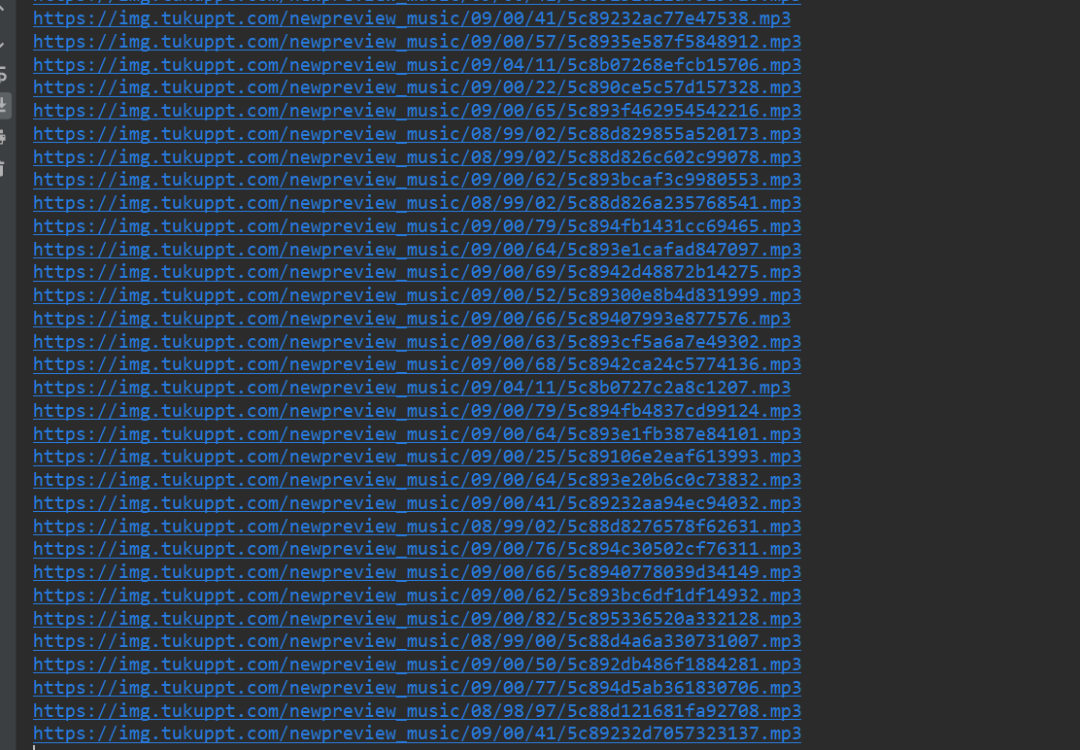

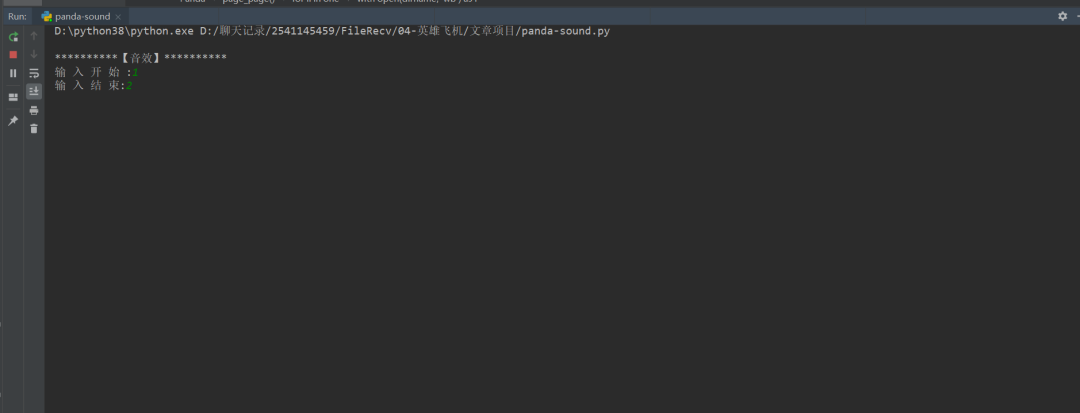

5、运行的结果,如下图:

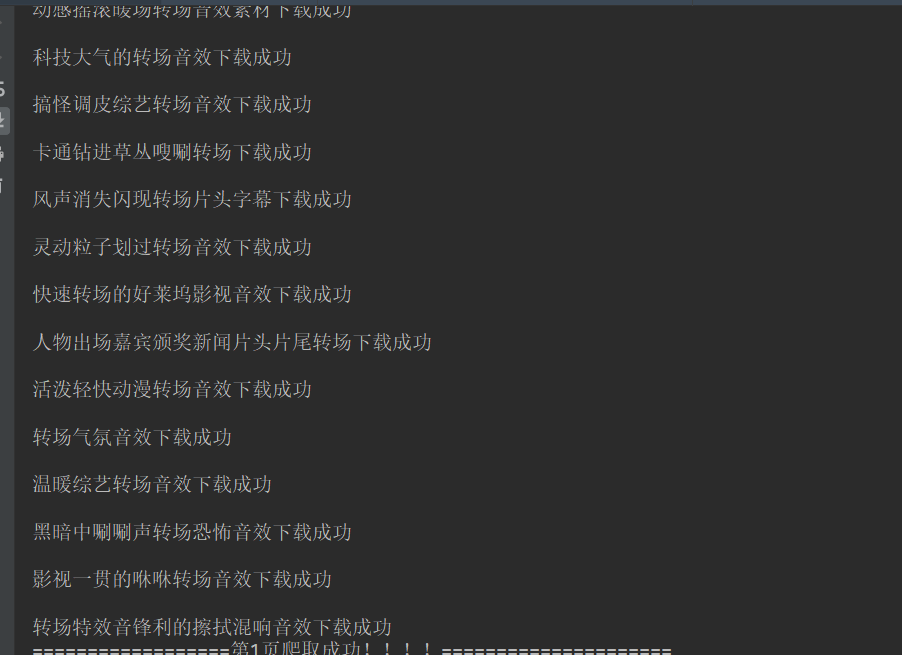

6、请求音效地址,获取音效a标签对应的text()作为名称,写入文件。

dirname = "./音效/" + who + '.mp3'html2 = requests.get(url=mp3, headers=self.headers).contentwith open(dirname, 'wb') as f: f.write(html2) print("\n%s下载成功" % who))

7、调用方法实现功能。

html = self.get_page(url)self.parse_page(html)

/6 效果展示/

1、点击绿色三角运行,进入起始页和结束页,如1和2,获取1页信息。

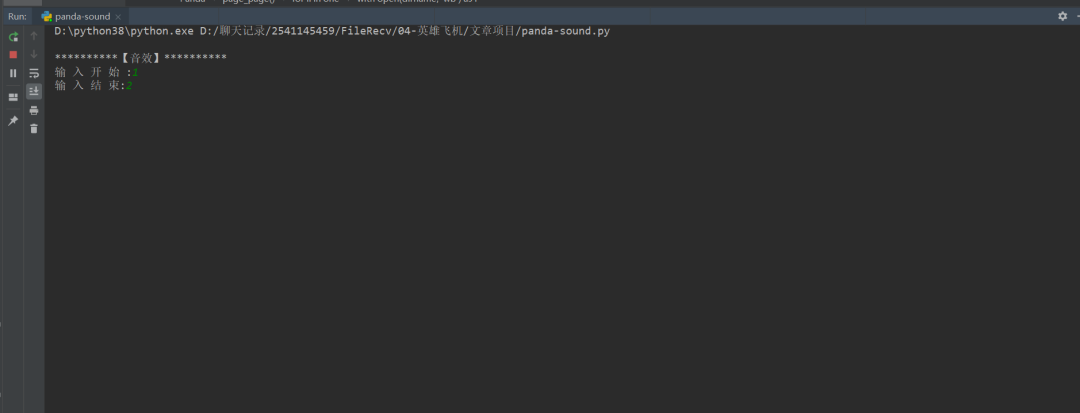

2、程序运行后,会在控制台显示结果,如下图。

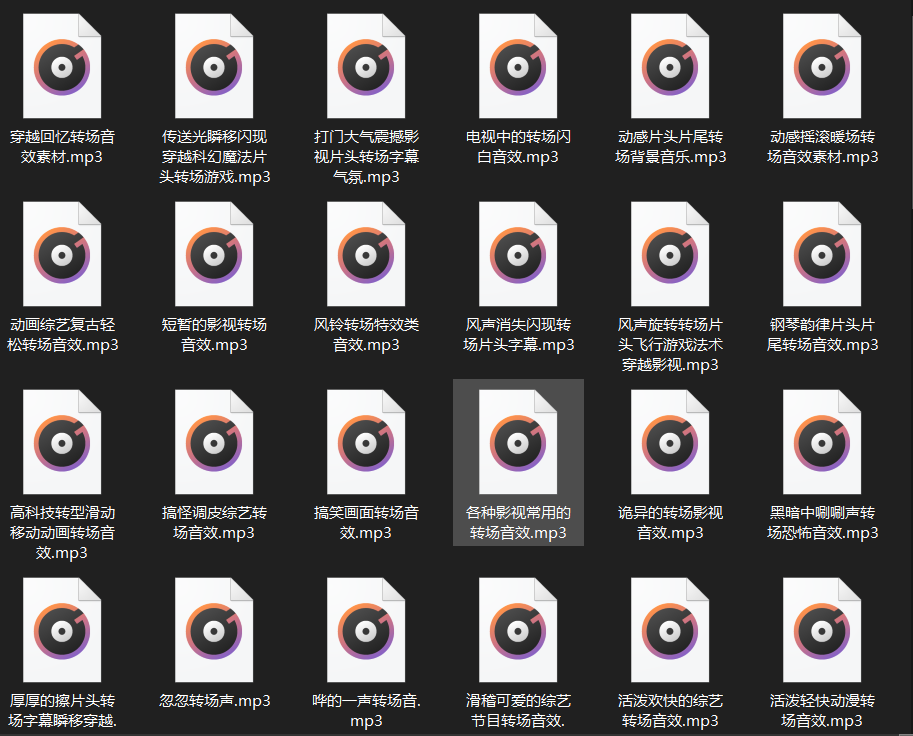

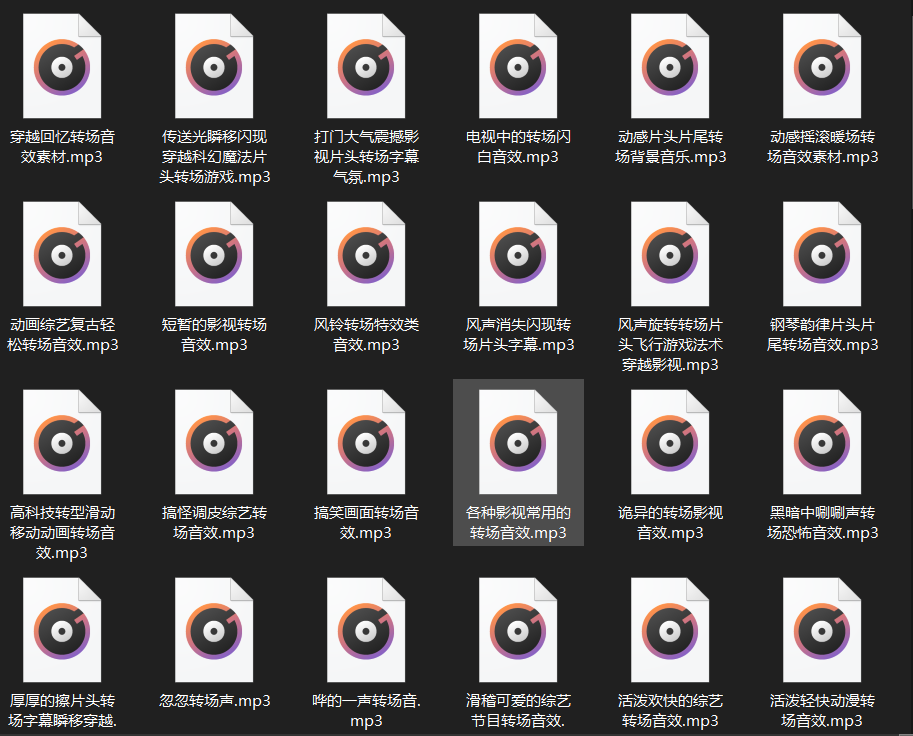

3、本地保存运行结果,如下图。

4、双击文件播放。

/7 总结/

1、 不建议取太多数据,可能造成服务器负载,简单试一下。 2、本文基于Python网络爬虫,利用爬虫库去除登录限制,下载音效,保存在文档中。 3、 按照步骤实现它。实施的时候总会遇到各种各样的问题。不看高手,努力去更深入地理解它。 4、希望通过这个项目,让大家对HTTPS网站和去除ssl验证有一个大致的了解。

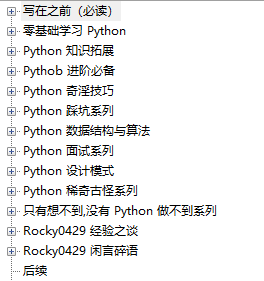

我把我的原创文章整理成一本电子书,名为《Python实践之道》。它有 400 页和 17w+ 个字。内容如下:

现在免费送给大家,在公众号后台回复修真道即可领取。

最后,我最近成立了一个读者交流群。想要加入的可以在公众号后台回复“加群”~

推荐阅读:爆肝整理 400 页 《Python 修炼之道》,高清电子书送给一直支持我的读者!打脸!这款百度的产品,良心的很不百度真香!我挖到了一款超级强大的 SQL 工具!这个插件,牛逼!

查看全部

抓取网页音频(

Python修炼之道400页17w+字,目录如下!

)

4、如何获取cookies?

右击检查,找到网络,然后复制一个cookie:

/5 项目实现/

1、定义一个类继承对象,定义init方法继承self,main函数main继承self。导入需要的库和URL,代码如下。

import requestsfrom lxml import etreefrom fake_useragent import UserAgentimport sslclass Panda(object): def __init__(self): pass def main(self): passif __name__ == '__main__': imageSpider = Panda() imageSpider.main()

2、Import URL 并构造请求头。

self.url = "https://www.tukuppt.com/yinxia ... _0_0_{}.html" #/zhuanchang/:搜索的名字的拼音缩写 self.headers = { "User-Agent": "Mozilla/5.0 (Macintosh; Intel Mac OS X 10_11_6) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/70.0.3538.77 Safari/537.36" }

3、发送请求获取响应,页面回调,方便下次请求。

def get_page(self, url): res = requests.get(url=url, headers=self.headers) html = res.content.decode("utf-8") return html

4、xpath 解析页面数据。

这里先获取父节点,通过for循环遍历找到对应的子节点(音效地址)。

one = parse_html.xpath('//div[@]//dl') for li in one: lis_imges = li.xpath(".//audio//source/@src")[0].strip() who = li.xpath(".//dt//a/text()")[0].strip()

获取后发现地址代表完整地址,需要填写网站才能获取实际地址。

mp3 = "https:" + lis_imges

5、运行的结果,如下图:

6、请求音效地址,获取音效a标签对应的text()作为名称,写入文件。

dirname = "./音效/" + who + '.mp3'html2 = requests.get(url=mp3, headers=self.headers).contentwith open(dirname, 'wb') as f: f.write(html2) print("\n%s下载成功" % who))

7、调用方法实现功能。

html = self.get_page(url)self.parse_page(html)

/6 效果展示/

1、点击绿色三角运行,进入起始页和结束页,如1和2,获取1页信息。

2、程序运行后,会在控制台显示结果,如下图。

3、本地保存运行结果,如下图。

4、双击文件播放。

/7 总结/

1、 不建议取太多数据,可能造成服务器负载,简单试一下。 2、本文基于Python网络爬虫,利用爬虫库去除登录限制,下载音效,保存在文档中。 3、 按照步骤实现它。实施的时候总会遇到各种各样的问题。不看高手,努力去更深入地理解它。 4、希望通过这个项目,让大家对HTTPS网站和去除ssl验证有一个大致的了解。

我把我的原创文章整理成一本电子书,名为《Python实践之道》。它有 400 页和 17w+ 个字。内容如下:

现在免费送给大家,在公众号后台回复修真道即可领取。

最后,我最近成立了一个读者交流群。想要加入的可以在公众号后台回复“加群”~

推荐阅读:爆肝整理 400 页 《Python 修炼之道》,高清电子书送给一直支持我的读者!打脸!这款百度的产品,良心的很不百度真香!我挖到了一款超级强大的 SQL 工具!这个插件,牛逼!

抓取网页音频(如何在手机App中的数据抓取得到App数据的作业)

网站优化 • 优采云 发表了文章 • 0 个评论 • 91 次浏览 • 2021-09-10 13:07

前两天,知识星球上的一个高尔夫球手要求分配一个任务来捕获应用程序数据,所以我一言不发地答应了。

效果图如下

我们过去常常在网络上抓取数据,我们很少在移动应用中抓取数据。那么我们如何抓取移动应用中的数据呢?一般我们使用抓包工具来抓数据。

常用的捕获工具是 Fiddles 和 Charles。今天主要讲一下Charles的使用。与 Fiddles 相比,Charles 更强大,更易于使用。所以一般我推荐使用 Charles

下载并安装 Charles

下载安装Charles然后破解Charles,这里是文章教程,我就不多说了

注意事项:

如果获取到的数据是乱码,需要在Charles的菜单栏中设置连接SSL证书==>proxy==>SSL代理设置==>添加443,如上图所示。那么当你实际在抓取数据的时候记得把这个关掉,以免获取数据。

使用查尔斯

这里直接放两张图给大家使用看看就明白了

我们一起来分析一下这个项目。

# 这里有点递归的意味

max_id = datas[-1]['publish_time_stamp']

if self.max_id != max_id:

self.max_id = max_id

self.request_data()

else:

print('数据抓取完毕!')

完整代码:

import requests

import time

import json

from dedao.ExeclUtils import ExeclUtils

import os

class dedao(object):

def __init__(self):

# self.rows_title = [u'招聘标题', u'公司名称', u'公司地址', u'待遇', u'发布日期', u'招聘链接', u'招聘要求描述']

# sheet_name = u'51job_Python招聘'

self.rows_title = [u'来源目录', u'标题', u'图片', u'分享标题', u'mp3地址', u'音频时长', u'文件大小']

sheet_name = u'逻辑思维音频'

return_execl = ExeclUtils.create_execl(sheet_name, self.rows_title)

self.execl_f = return_execl[0]

self.sheet_table = return_execl[1]

self.audio_info = [] # 存放每一条数据中的各元素,

self.count = 0 # 数据插入从1开始的

self.base_url = 'https://entree.igetget.com/acr ... 27%3B

self.max_id = 0

self.headers = {

'Host': 'entree.igetget.com',

'X-OS': 'iOS',

'X-NET': 'wifi',

'Accept': '*/*',

'X-Nonce': '779b79d1d51d43fa',

'Accept-Encoding': 'br, gzip, deflate',

# 'Content-Length': ' 67',

'X-TARGET': 'main',

'User-Agent': '%E5%BE%97%E5%88%B0/4.0.13 CFNetwork/901.1 Darwin/17.6.0',

'X-CHIL': 'appstore',

'Cookie ': 'acw_tc=AQAAAC0YfiuHegUAxkvoZRLraUMQyRfH; aliyungf_tc=AQAAAKwCD1dINAUAxkvoZTppW+jezS/9',

'X-UID': '34556154',

'X-AV ': '4.0.0',

'X-SEID ': '',

'X-SCR ': '1242*2208',

'X-DT': 'phone',

'X-S': '91a46b7a31ffc7a2',

'X-Sign': 'ZTBiZjQyNTI1OTU2MTgwZjYwMWRhMjc5ZjhmMGRlNGI=',

'Accept-Language': 'zh-cn',

'X-D': 'ca3c83fca6e84a2d869f95829964ebb8',

'X-THUMB': 'l',

'X-T': 'json',

'X-Timestamp': '1528195376',

'X-TS': '1528195376',

'X-U': '34556154',

'X-App-Key': 'ios-4.0.0',

'X-OV': '11.4',

'Connection': 'keep-alive',

'X-ADV': '1',

'Content-Type': 'application/x-www-form-urlencoded',

'X-V': '2',

'X-IS_JAILBREAK ': 'NO',

'X-DV': 'iPhone10,2',

}

def request_data(self):

try:

data = {

'max_id': self.max_id,

'since_id': 0,

'column_id': 2,

'count': 20,

'order': 1,

'section': 0

}

response = requests.post(self.base_url, headers=self.headers, data=data)

if 200 == response.status_code:

self.parse_data(response)

except Exception as e:

print(e)

time.sleep(2)

pass

def parse_data(self, response):

dict_json = json.loads(response.text)

datas = dict_json['c']['list'] # 这里取得数据列表

# print(datas)

for data in datas:

source_name = data['audio_detail']['source_name']

title = data['audio_detail']['title']

icon = data['audio_detail']['icon']

share_title = data['audio_detail']['share_title']

mp3_url = data['audio_detail']['mp3_play_url']

duction = str(data['audio_detail']['duration']) + '秒'

size = data['audio_detail']['size'] / (1000 * 1000)

size = '%.2fM' % size

self.download_mp3(mp3_url)

self.audio_info.append(source_name)

self.audio_info.append(title)

self.audio_info.append(icon)

self.audio_info.append(share_title)

self.audio_info.append(mp3_url)

self.audio_info.append(duction)

self.audio_info.append(size)

self.count = self.count + 1

ExeclUtils.write_execl(self.execl_f, self.sheet_table, self.count, self.audio_info, u'逻辑思维音频.xlsx')

print('采集了{}条数据'.format(self.count))

# 清空集合,为再次存放数据做准备

self.audio_info = []

time.sleep(3) # 不要请求太快, 小心查水表

max_id = datas[-1]['publish_time_stamp']

if self.max_id != max_id:

self.max_id = max_id

self.request_data()

else:

print('数据抓取完毕!')

pass

def download_mp3(self, mp3_url):

try:

# 补全文件目录

mp3_path = u'D:/store/mp3/{}'.format(mp3_url.split('/')[-1])

print(mp3_path)

# 判断文件是否存在。

if not os.path.exists(mp3_path):

# 注意这里是写入文件,要用二进制格式写入。

with open(mp3_path, 'wb') as f:

f.write(requests.get(mp3_url).content)

except Exception as e:

print(e)

if __name__ == '__main__':

d = dedao()

d.request_data()

目前,这只是一个相对简单的移动应用数据捕获。如何操作更复杂的数据采集?如何抓取朋友圈的数据?如何抓取微信公众号数据?敬请期待! 查看全部

抓取网页音频(如何在手机App中的数据抓取得到App数据的作业)

前两天,知识星球上的一个高尔夫球手要求分配一个任务来捕获应用程序数据,所以我一言不发地答应了。

效果图如下

我们过去常常在网络上抓取数据,我们很少在移动应用中抓取数据。那么我们如何抓取移动应用中的数据呢?一般我们使用抓包工具来抓数据。

常用的捕获工具是 Fiddles 和 Charles。今天主要讲一下Charles的使用。与 Fiddles 相比,Charles 更强大,更易于使用。所以一般我推荐使用 Charles

下载并安装 Charles

下载安装Charles然后破解Charles,这里是文章教程,我就不多说了

注意事项:

如果获取到的数据是乱码,需要在Charles的菜单栏中设置连接SSL证书==>proxy==>SSL代理设置==>添加443,如上图所示。那么当你实际在抓取数据的时候记得把这个关掉,以免获取数据。

使用查尔斯

这里直接放两张图给大家使用看看就明白了

我们一起来分析一下这个项目。

# 这里有点递归的意味

max_id = datas[-1]['publish_time_stamp']

if self.max_id != max_id:

self.max_id = max_id

self.request_data()

else:

print('数据抓取完毕!')

完整代码:

import requests

import time

import json

from dedao.ExeclUtils import ExeclUtils

import os

class dedao(object):

def __init__(self):

# self.rows_title = [u'招聘标题', u'公司名称', u'公司地址', u'待遇', u'发布日期', u'招聘链接', u'招聘要求描述']

# sheet_name = u'51job_Python招聘'

self.rows_title = [u'来源目录', u'标题', u'图片', u'分享标题', u'mp3地址', u'音频时长', u'文件大小']

sheet_name = u'逻辑思维音频'

return_execl = ExeclUtils.create_execl(sheet_name, self.rows_title)

self.execl_f = return_execl[0]

self.sheet_table = return_execl[1]

self.audio_info = [] # 存放每一条数据中的各元素,

self.count = 0 # 数据插入从1开始的

self.base_url = 'https://entree.igetget.com/acr ... 27%3B

self.max_id = 0

self.headers = {

'Host': 'entree.igetget.com',

'X-OS': 'iOS',

'X-NET': 'wifi',

'Accept': '*/*',

'X-Nonce': '779b79d1d51d43fa',

'Accept-Encoding': 'br, gzip, deflate',

# 'Content-Length': ' 67',

'X-TARGET': 'main',

'User-Agent': '%E5%BE%97%E5%88%B0/4.0.13 CFNetwork/901.1 Darwin/17.6.0',

'X-CHIL': 'appstore',

'Cookie ': 'acw_tc=AQAAAC0YfiuHegUAxkvoZRLraUMQyRfH; aliyungf_tc=AQAAAKwCD1dINAUAxkvoZTppW+jezS/9',

'X-UID': '34556154',

'X-AV ': '4.0.0',

'X-SEID ': '',

'X-SCR ': '1242*2208',

'X-DT': 'phone',

'X-S': '91a46b7a31ffc7a2',

'X-Sign': 'ZTBiZjQyNTI1OTU2MTgwZjYwMWRhMjc5ZjhmMGRlNGI=',

'Accept-Language': 'zh-cn',

'X-D': 'ca3c83fca6e84a2d869f95829964ebb8',

'X-THUMB': 'l',

'X-T': 'json',

'X-Timestamp': '1528195376',

'X-TS': '1528195376',

'X-U': '34556154',

'X-App-Key': 'ios-4.0.0',

'X-OV': '11.4',

'Connection': 'keep-alive',

'X-ADV': '1',

'Content-Type': 'application/x-www-form-urlencoded',

'X-V': '2',

'X-IS_JAILBREAK ': 'NO',

'X-DV': 'iPhone10,2',

}

def request_data(self):

try:

data = {

'max_id': self.max_id,

'since_id': 0,

'column_id': 2,

'count': 20,

'order': 1,

'section': 0

}

response = requests.post(self.base_url, headers=self.headers, data=data)

if 200 == response.status_code:

self.parse_data(response)

except Exception as e:

print(e)

time.sleep(2)

pass

def parse_data(self, response):

dict_json = json.loads(response.text)

datas = dict_json['c']['list'] # 这里取得数据列表

# print(datas)

for data in datas:

source_name = data['audio_detail']['source_name']

title = data['audio_detail']['title']

icon = data['audio_detail']['icon']

share_title = data['audio_detail']['share_title']

mp3_url = data['audio_detail']['mp3_play_url']

duction = str(data['audio_detail']['duration']) + '秒'

size = data['audio_detail']['size'] / (1000 * 1000)

size = '%.2fM' % size

self.download_mp3(mp3_url)

self.audio_info.append(source_name)

self.audio_info.append(title)

self.audio_info.append(icon)

self.audio_info.append(share_title)

self.audio_info.append(mp3_url)

self.audio_info.append(duction)

self.audio_info.append(size)

self.count = self.count + 1

ExeclUtils.write_execl(self.execl_f, self.sheet_table, self.count, self.audio_info, u'逻辑思维音频.xlsx')

print('采集了{}条数据'.format(self.count))

# 清空集合,为再次存放数据做准备

self.audio_info = []

time.sleep(3) # 不要请求太快, 小心查水表

max_id = datas[-1]['publish_time_stamp']

if self.max_id != max_id:

self.max_id = max_id

self.request_data()

else:

print('数据抓取完毕!')

pass

def download_mp3(self, mp3_url):

try:

# 补全文件目录

mp3_path = u'D:/store/mp3/{}'.format(mp3_url.split('/')[-1])

print(mp3_path)

# 判断文件是否存在。

if not os.path.exists(mp3_path):

# 注意这里是写入文件,要用二进制格式写入。

with open(mp3_path, 'wb') as f:

f.write(requests.get(mp3_url).content)

except Exception as e:

print(e)

if __name__ == '__main__':

d = dedao()

d.request_data()

目前,这只是一个相对简单的移动应用数据捕获。如何操作更复杂的数据采集?如何抓取朋友圈的数据?如何抓取微信公众号数据?敬请期待!

抓取网页音频(网页上的“下载”往往会提示你下载APP直接获取一段音频)

网站优化 • 优采云 发表了文章 • 0 个评论 • 170 次浏览 • 2021-09-09 10:12

情况描述

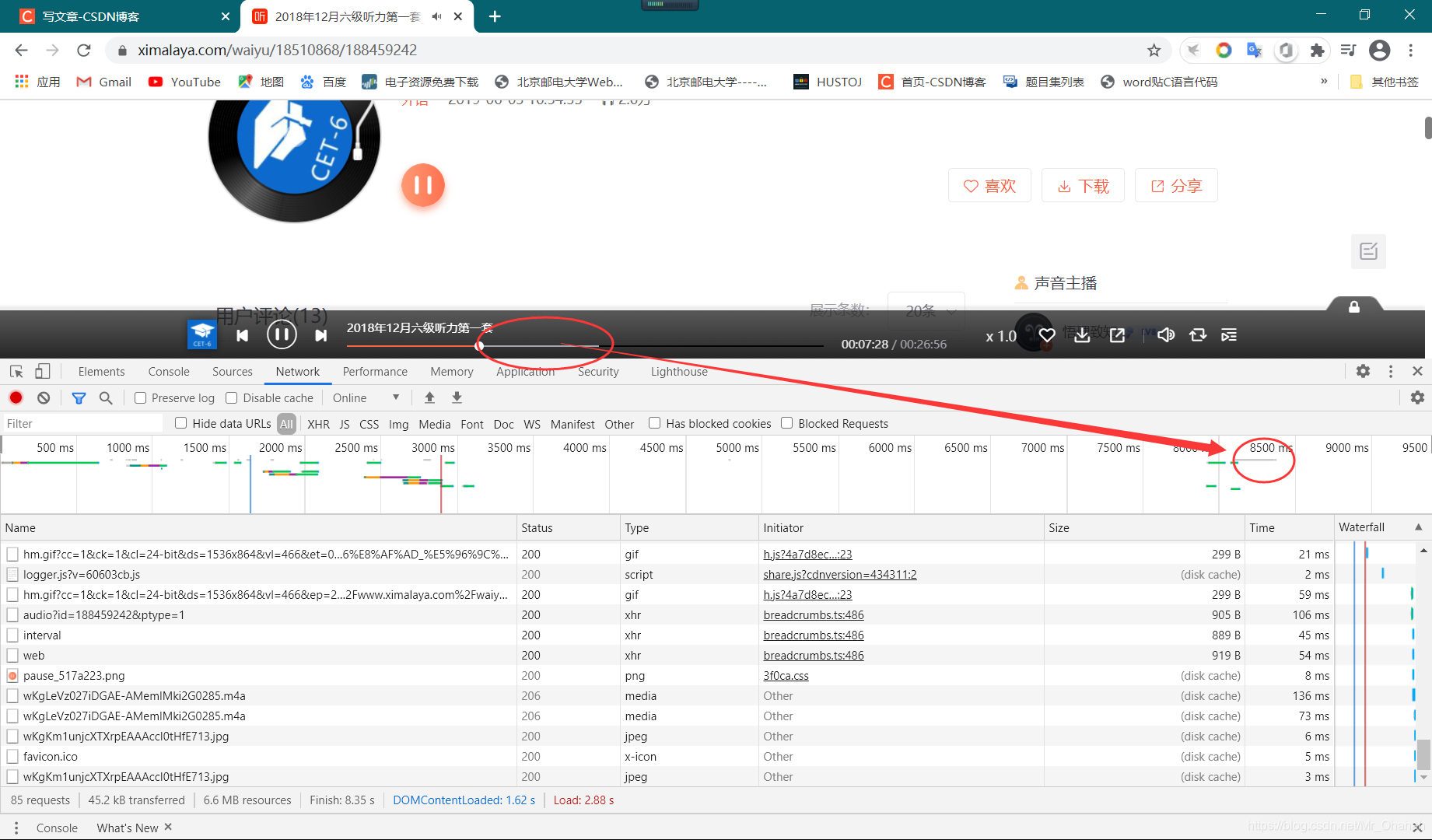

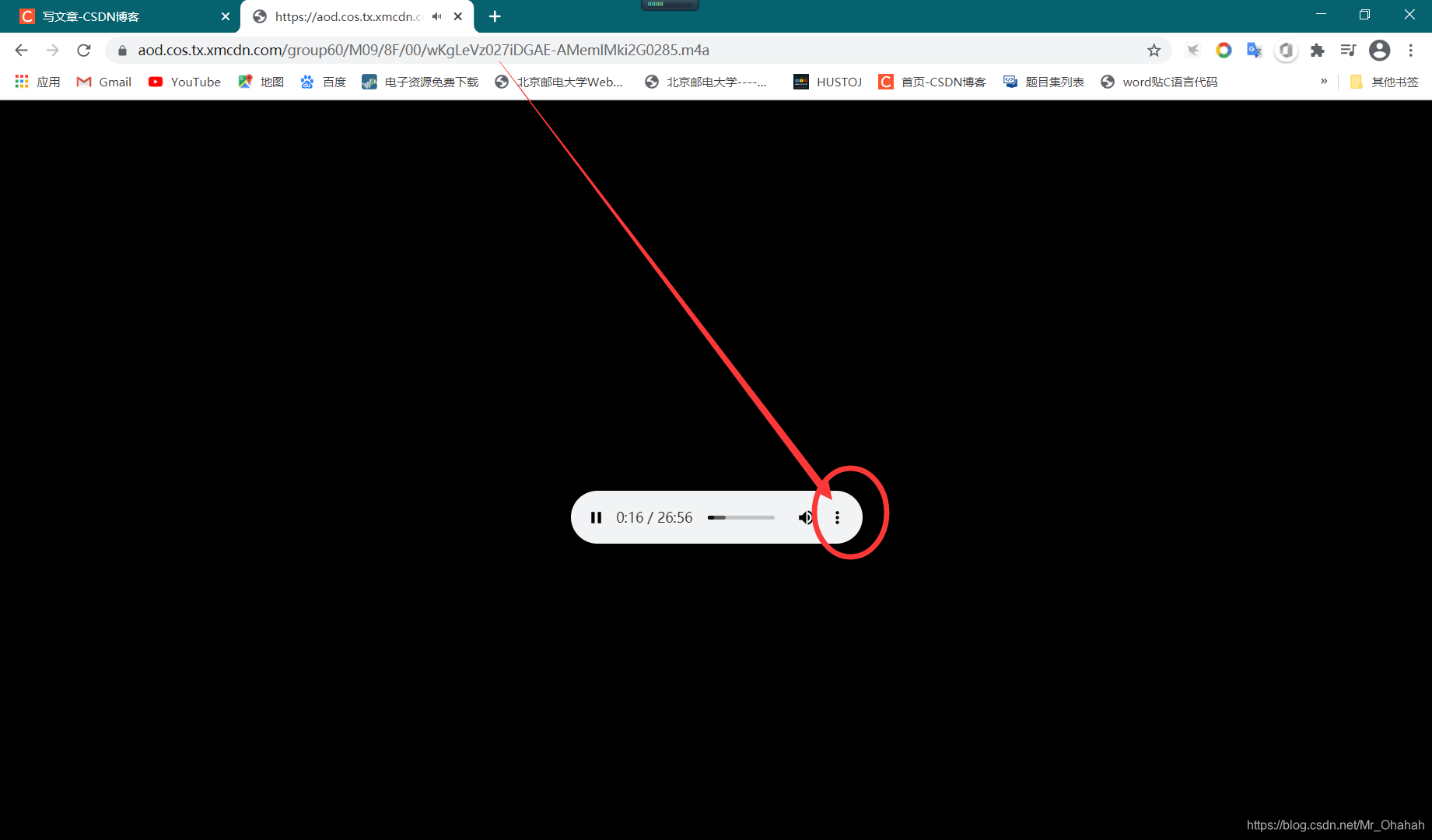

在网上冲浪时,有时会遇到想要获取的音乐或音频文件,但碰巧访问的网页是例如某个云网页版本。在网页上点击“下载”经常会提示下载某个app,很烦,同时又想保存音频,怎么办?

网页音视频加载逻辑

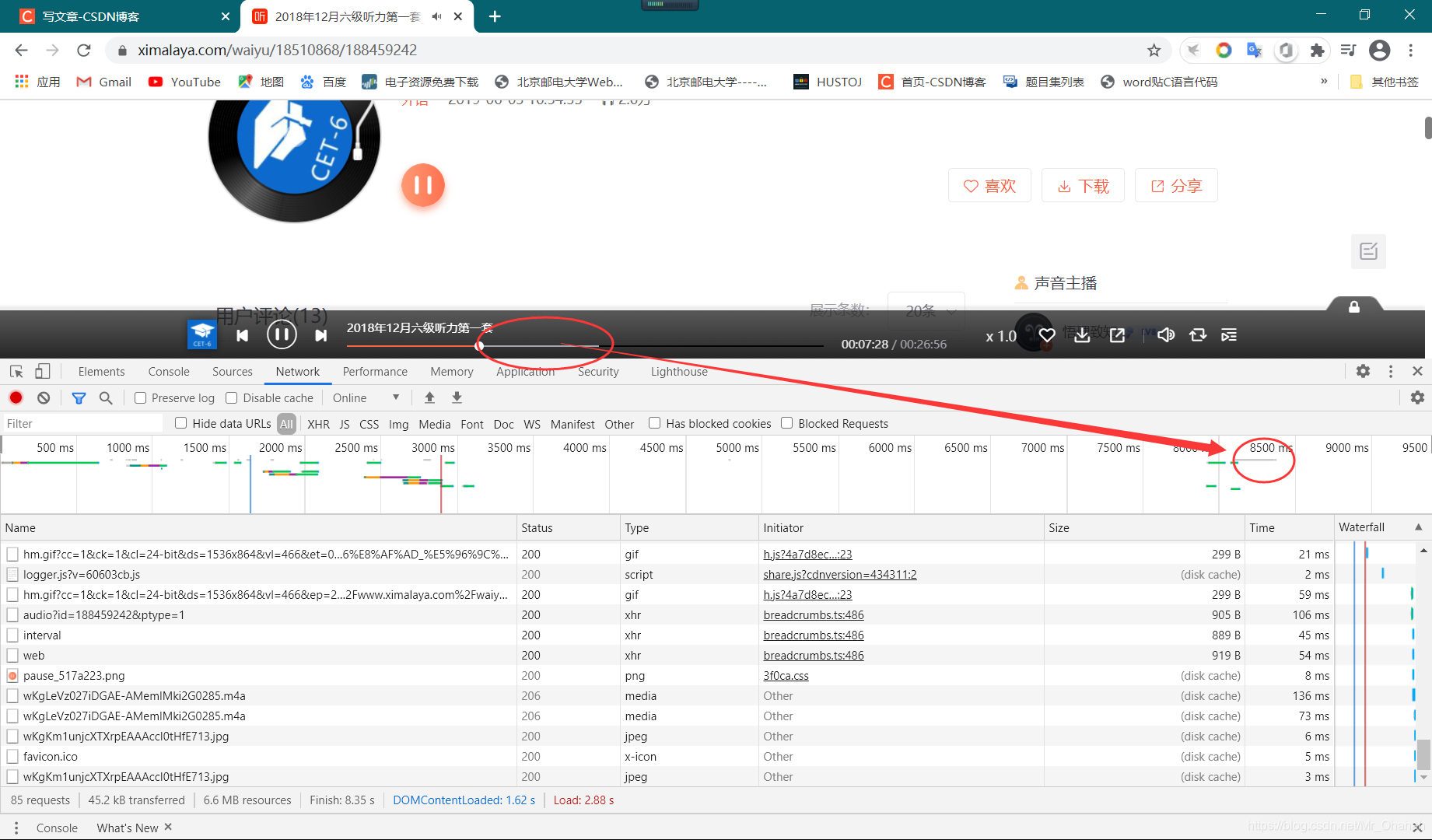

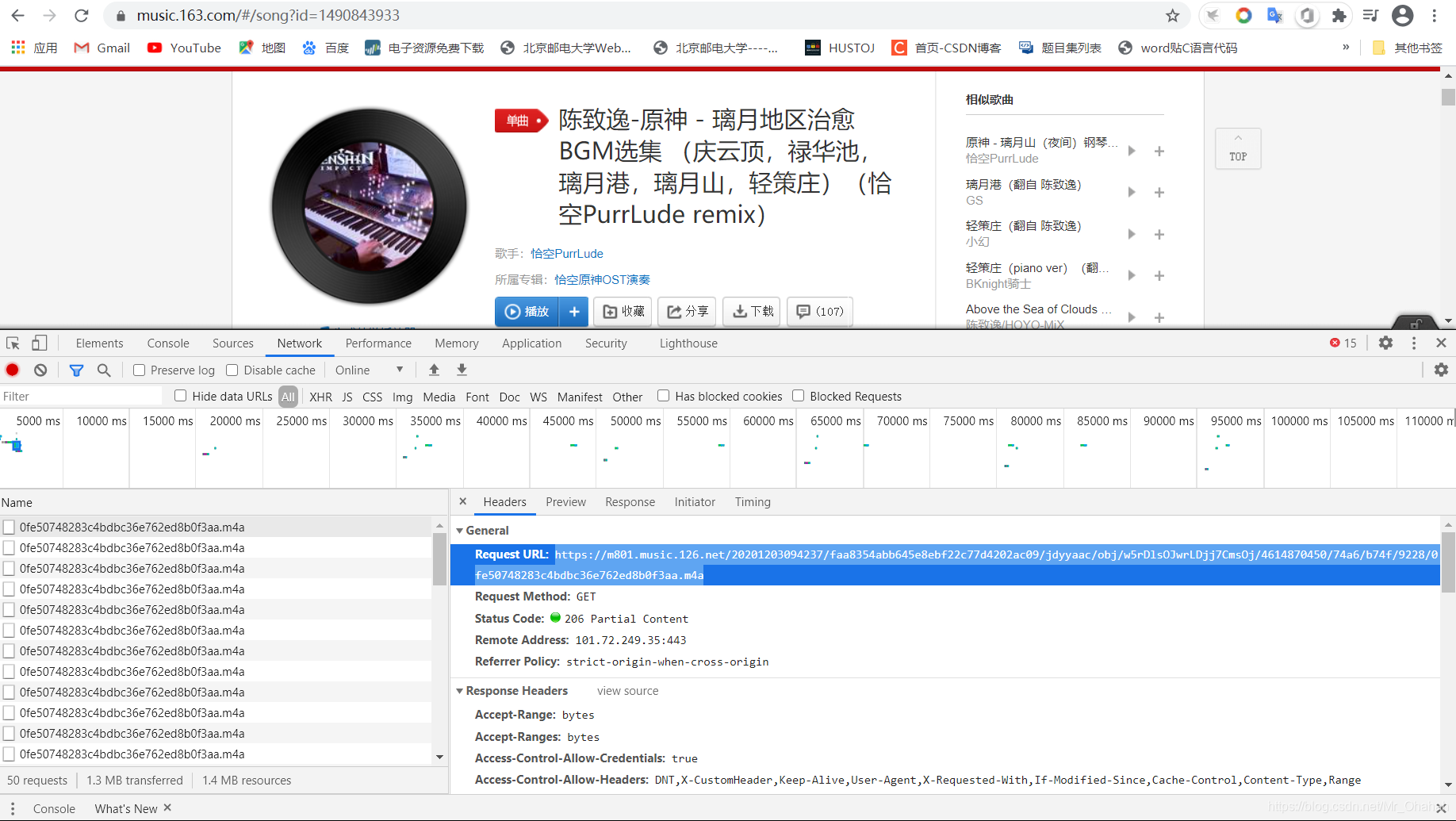

对于这些小音乐网页版,其实是(或者一般来说)你播放它,服务器给你发送一个你实际访问的音视频的数据包。所以在这种情况下,根本不需要尝试从应用程序下载,只需要一个浏览器。

使用浏览器直接下载小音频(示例)

例如,我真的很喜欢六级聆听音频:

如果您点击“下载”,您会发现:

死了,但我还是想直接下载音频。

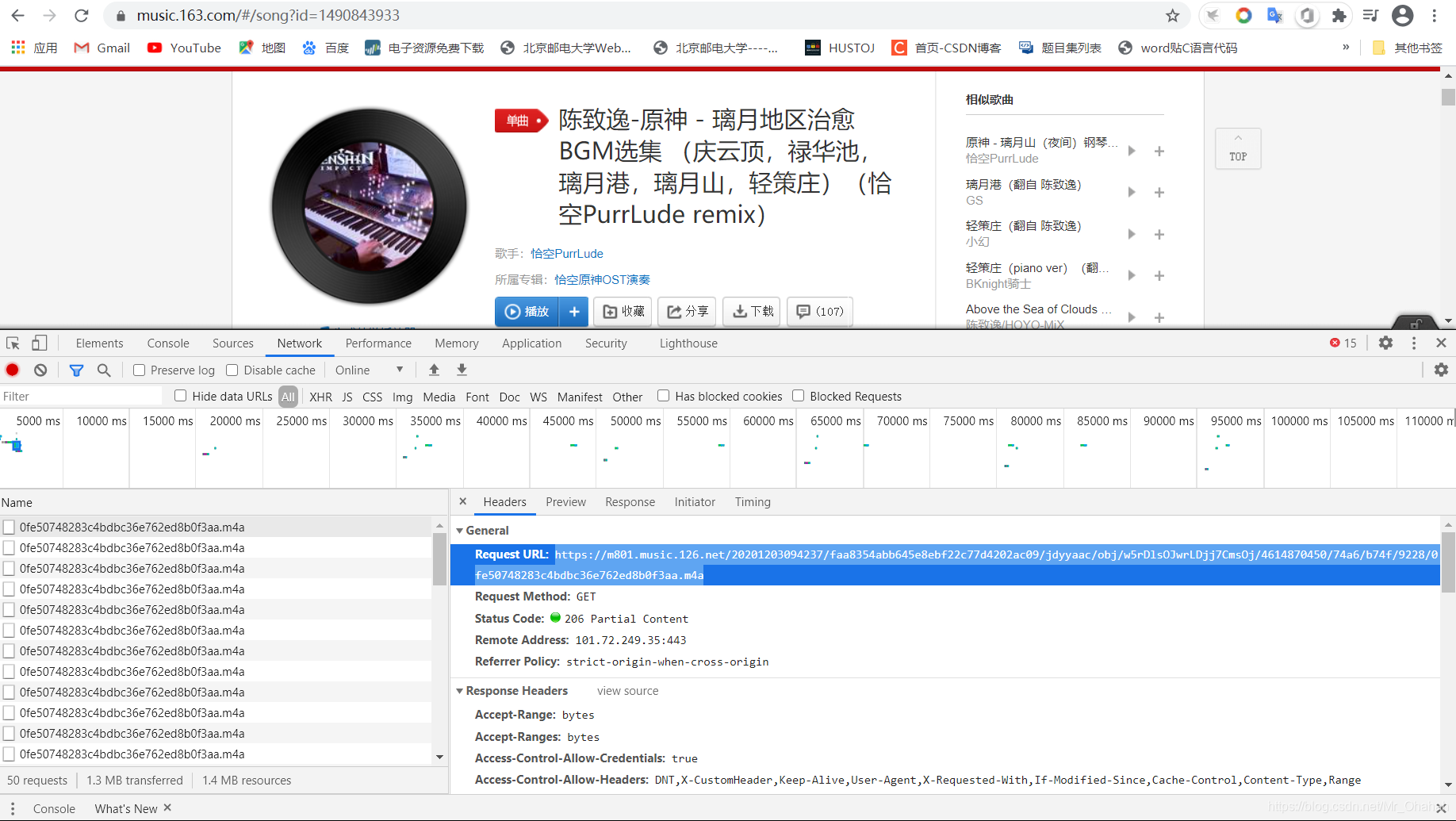

我使用的是谷歌Chrome浏览器,点击F12,点击网络,然后刷新页面,然后再次开始播放这个音频:

播放开始后,发现数据流突然加了一小段,同时缓冲条也加了一段。相关程度很明显,这个数据流估计就是我们想要的了。

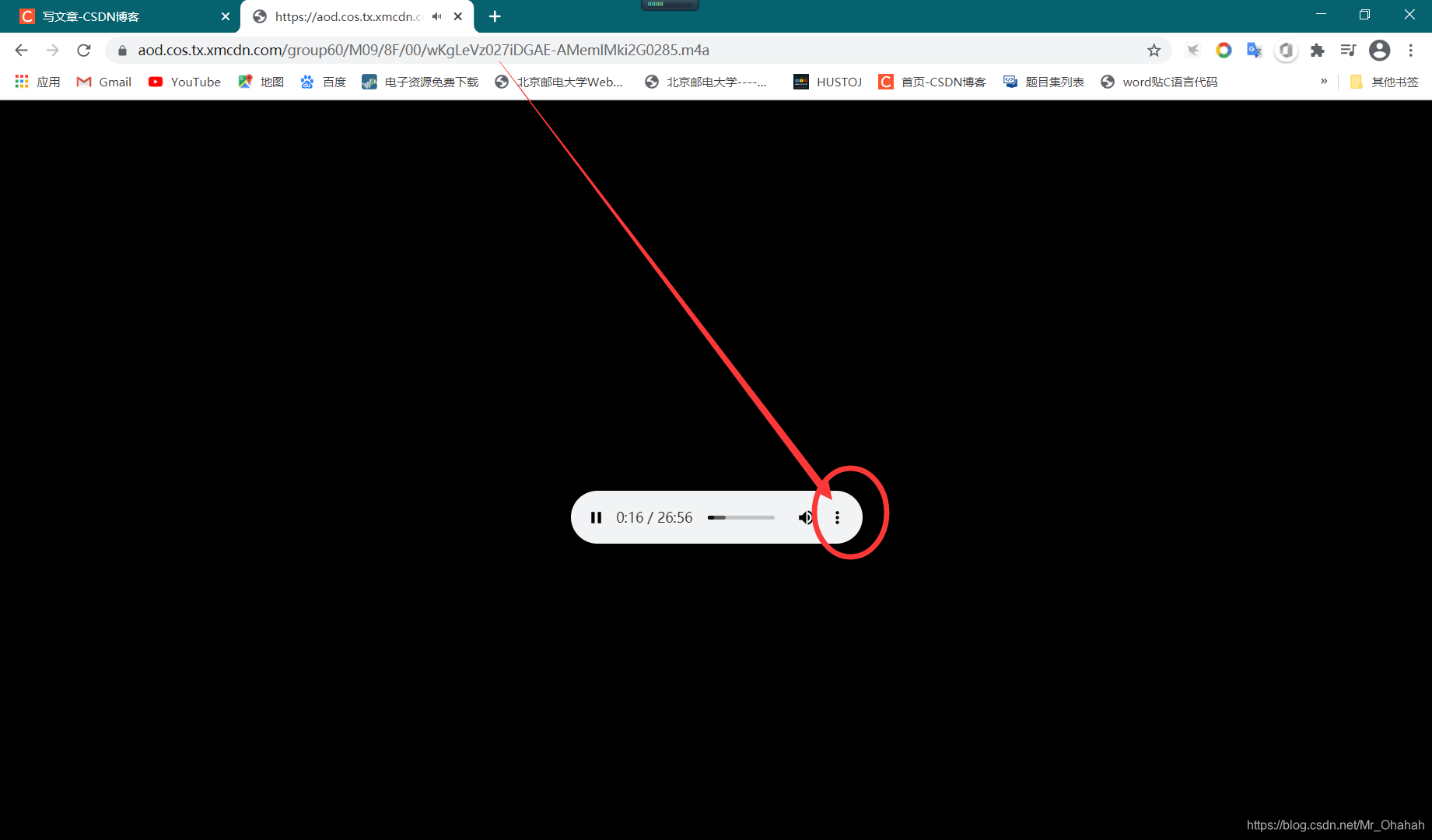

点一下,没错,大家都知道.m4a是音频文件。所以如果我们复制Request Url的链接,在地址栏中访问,就可以直接通过浏览器访问整个音频文件了:

好的,点击这里立即下载。不管是什么网页版的音乐软件,不用下载APP就可以直接用这个技巧获取一段音频(当然你也有可能失去享受SQ的机会)

希望对大家有帮助! 查看全部

抓取网页音频(网页上的“下载”往往会提示你下载APP直接获取一段音频)

情况描述

在网上冲浪时,有时会遇到想要获取的音乐或音频文件,但碰巧访问的网页是例如某个云网页版本。在网页上点击“下载”经常会提示下载某个app,很烦,同时又想保存音频,怎么办?

网页音视频加载逻辑

对于这些小音乐网页版,其实是(或者一般来说)你播放它,服务器给你发送一个你实际访问的音视频的数据包。所以在这种情况下,根本不需要尝试从应用程序下载,只需要一个浏览器。

使用浏览器直接下载小音频(示例)

例如,我真的很喜欢六级聆听音频:

如果您点击“下载”,您会发现:

死了,但我还是想直接下载音频。

我使用的是谷歌Chrome浏览器,点击F12,点击网络,然后刷新页面,然后再次开始播放这个音频:

播放开始后,发现数据流突然加了一小段,同时缓冲条也加了一段。相关程度很明显,这个数据流估计就是我们想要的了。

点一下,没错,大家都知道.m4a是音频文件。所以如果我们复制Request Url的链接,在地址栏中访问,就可以直接通过浏览器访问整个音频文件了:

好的,点击这里立即下载。不管是什么网页版的音乐软件,不用下载APP就可以直接用这个技巧获取一段音频(当然你也有可能失去享受SQ的机会)

希望对大家有帮助!

抓取网页音频(一下R和python抓取数据的技术分工(一) )

网站优化 • 优采云 发表了文章 • 0 个评论 • 140 次浏览 • 2021-09-09 08:06

)

获取信息的能力往往是个人或组织取得成就的关键。从二战时期的恩格玛密码开始,人类进入了信息时代,信息开始在各个领域发挥越来越大的作用,甚至成为独立于其他资源的一种资源。

数据分析挖掘人员除了研究公司自身的数据外,还必须能够获取外部公开数据和二手数据,更加注重内外部数据的结合。聪明的女人不做饭是很难做饭的。当自身数据资源稀缺时,必须具备获取外部数据的能力,帮助企业和个人做出决策。不走在前面,我就去山里挖矿。在本章中,我们将重点学习R和python捕获数据的技术。

>获取信息的能力与其他专业技能一样重要。在深度分工的社会中,我们必须更加注重信息的广度。

复制代码

首先,我们来看看 R 来捕获常见的网络数据。要捕获数据,我们必须首先虚拟化一个命令行浏览器。 `RCurl` 包是 R 语言的命令行浏览器; `XML` 包用于解析和处理。浏览器接收到的 XML 或 HTML 数据;数据解析完成后,还需要做一些数据整理工作。 `stringr` 是处理字符数据的最佳选择。

###加载数据包

if (!suppressWarnings(require(RCurl))) {

install.packages("RCurl")

需要(RCurl)

}

if (!suppressWarnings(require(XML))) {

install.packages("XML")

要求(XML)

}

if (!suppressWarnings(require(stringr))) {

install.packages("stringr")

要求(字符串)

}

复制代码

在捕获数据之前,您需要了解网络数据的格式。网络数据一般包括文本、表格、超文本标记语言(HTML)、JSON等,以及获取数据时是否有权限限制等。事先清楚了解,一方面为了选择合适的捕获另一方面,如果有错误或困难,您可以详细描述您的问题,以便其他人可以提供帮助。

按照分步介绍的方法。首先,从简单地阅读文本格式的网页文本开始,然后从古腾堡 (``) 中获取一份“国富论的性质和原因的调查”。 ,这本书的名字直译为《国民财富的性质和原因的研究》,他还有一个更响亮的名字,《致富论》。世人尊称亚当·斯密为“现代经济学之父”和“自由企业的守护神”,人类第一次认识了看不见的手(`invisible hand`)。无形之手在不知不觉中引导自私的人类谋求自己的利益。在促进全人类利益发展的同时,今天我们将用R来捕捉这本书的全部内容,以纪念这位人类精英。

###读取文本数据

url fuguolun temp write.table(temp, "G:/zimeiti/dzdata/fuguolun.txt")

复制代码

直接使用R基础包中的`readLines`函数完整阅读“傅国伦”理论。 `readLines`有很多参数,最有用的是`n`和`encoding`两个参数,前者用于指定读取文本的前几行,后者用于指定文本的字符编码。另外,`readLines`函数读取的结果是一个列表对象,文本的每一行(注意:文本中的一行字符代表我们正在谈论的内容)都是列表的一个元素。

如果直接把list输出为txt,R会在每段开头加上list元素的编号,不符合电子书的格式,所以需要将它们合并成一定的格式,例如对每一行使用换行符。可以使用“粘贴”功能将它们粘合在一起。注意粘贴函数的两个参数sep和collapse,是用来设置用什么分隔符来分隔粘贴的。用法略有不同。如果要将`vector` 对象粘合在一起,以逗号分隔,请设置`sep = ","` 而不是设置`collapse`,如果要将`list` 对象粘合在一起,请使用`collapse = "," `.这里是后者,但选择的分隔符是`\n`。

然后使用`write.table`函数将调整后的文件写入指定目录。在这里我们得到了“福国论”,它被称为“福国论”,值得一提。同年,在乾隆皇帝在全国推行“销书以正人心”等文化调控政策之时,东西方的横向对比让人感慨万千。

以上是一个小测试。在为自己准备了一份精神食粮《富国论》之后,就可以开始尝试捕捉一些更难的数据了。股票应该是很多人在学习数据挖掘的道路上经常幻想的突破口。不幸的是,大多数人在这里崩溃了。他们虽然没能完成预测行情的重任,但也锻炼了自己的个人本领。既然这条路留下了很多“先贤”的足迹,我们不妨在这里抢股数据。如果你的梦想成真了怎么办?

East 发布了大量股票数据。用这个宝来捕捉他们关于“中国梦”的股票交易数据也是一个不错的选择。据我所知,市场中隐藏着一大块老股民表示,龙虎板的机构交易数据往往可以预测未来的股票走势。机构看好,后者崛起,机构跑路,有可能成为挑剔者。我建议你不要相应地投资。以上是不负责任的言论。你不必认真对待它。成功捕获数据是本书的责任。

###HTML 格式

lhb

复制代码

首先解释一下URL“,”是东方财富网龙虎帮的数据; `600006`是股票代码,指的是东风汽车,可以用任何已知的股票代码替换,龙虎名单数据每天收盘后更新,读者可以根据需要抓取; `html`表示网页数据为超文本标记语言格式。

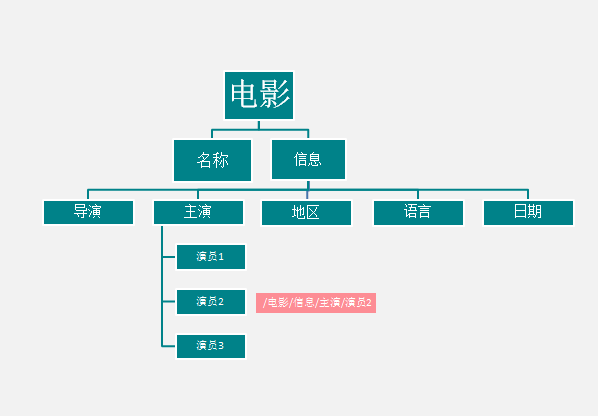

不得不说一下`html`的基本内容,它是一种描述和构造数据的语言。要在网页上显示数据,不仅要标记某个部分是什么文件,例如图片、音频、视频、文本等,还要标记它们的归属关系。这就是 `html` 和 `xml` 所做的。在浏览器中右击,选择(Ctrl+U)“查看网页源代码”,查看网页的标记语言文本。

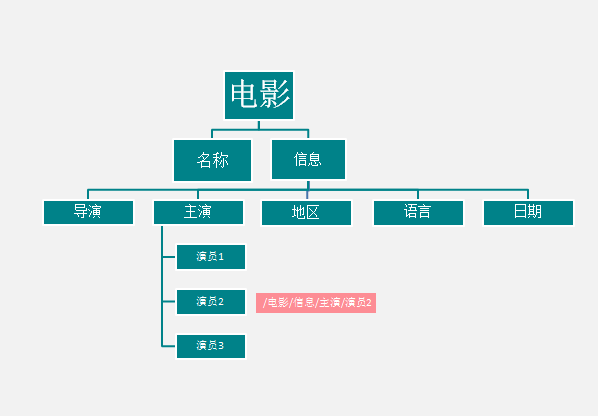

###简单的html结构

阳光灼伤我的心

导演:曹保平

主演:邓超/段奕宏/王珞丹/高虎

生产国家/地区:中国大陆

语言:普通话

发布日期:2015-08-27(中国大陆)

复制代码

`html` 一般分为头部和主体。 “和”之间描述了整个网页,包括网页的结构和标志等,“和”是网页的可见内容,`

`和`

`描述一个模块。树结构如下:

查看全部

抓取网页音频(一下R和python抓取数据的技术分工(一)

)

获取信息的能力往往是个人或组织取得成就的关键。从二战时期的恩格玛密码开始,人类进入了信息时代,信息开始在各个领域发挥越来越大的作用,甚至成为独立于其他资源的一种资源。

数据分析挖掘人员除了研究公司自身的数据外,还必须能够获取外部公开数据和二手数据,更加注重内外部数据的结合。聪明的女人不做饭是很难做饭的。当自身数据资源稀缺时,必须具备获取外部数据的能力,帮助企业和个人做出决策。不走在前面,我就去山里挖矿。在本章中,我们将重点学习R和python捕获数据的技术。

>获取信息的能力与其他专业技能一样重要。在深度分工的社会中,我们必须更加注重信息的广度。

复制代码

首先,我们来看看 R 来捕获常见的网络数据。要捕获数据,我们必须首先虚拟化一个命令行浏览器。 `RCurl` 包是 R 语言的命令行浏览器; `XML` 包用于解析和处理。浏览器接收到的 XML 或 HTML 数据;数据解析完成后,还需要做一些数据整理工作。 `stringr` 是处理字符数据的最佳选择。

###加载数据包

if (!suppressWarnings(require(RCurl))) {

install.packages("RCurl")

需要(RCurl)

}

if (!suppressWarnings(require(XML))) {

install.packages("XML")

要求(XML)

}

if (!suppressWarnings(require(stringr))) {

install.packages("stringr")

要求(字符串)

}

复制代码

在捕获数据之前,您需要了解网络数据的格式。网络数据一般包括文本、表格、超文本标记语言(HTML)、JSON等,以及获取数据时是否有权限限制等。事先清楚了解,一方面为了选择合适的捕获另一方面,如果有错误或困难,您可以详细描述您的问题,以便其他人可以提供帮助。

按照分步介绍的方法。首先,从简单地阅读文本格式的网页文本开始,然后从古腾堡 (``) 中获取一份“国富论的性质和原因的调查”。 ,这本书的名字直译为《国民财富的性质和原因的研究》,他还有一个更响亮的名字,《致富论》。世人尊称亚当·斯密为“现代经济学之父”和“自由企业的守护神”,人类第一次认识了看不见的手(`invisible hand`)。无形之手在不知不觉中引导自私的人类谋求自己的利益。在促进全人类利益发展的同时,今天我们将用R来捕捉这本书的全部内容,以纪念这位人类精英。

###读取文本数据

url fuguolun temp write.table(temp, "G:/zimeiti/dzdata/fuguolun.txt")

复制代码

直接使用R基础包中的`readLines`函数完整阅读“傅国伦”理论。 `readLines`有很多参数,最有用的是`n`和`encoding`两个参数,前者用于指定读取文本的前几行,后者用于指定文本的字符编码。另外,`readLines`函数读取的结果是一个列表对象,文本的每一行(注意:文本中的一行字符代表我们正在谈论的内容)都是列表的一个元素。

如果直接把list输出为txt,R会在每段开头加上list元素的编号,不符合电子书的格式,所以需要将它们合并成一定的格式,例如对每一行使用换行符。可以使用“粘贴”功能将它们粘合在一起。注意粘贴函数的两个参数sep和collapse,是用来设置用什么分隔符来分隔粘贴的。用法略有不同。如果要将`vector` 对象粘合在一起,以逗号分隔,请设置`sep = ","` 而不是设置`collapse`,如果要将`list` 对象粘合在一起,请使用`collapse = "," `.这里是后者,但选择的分隔符是`\n`。

然后使用`write.table`函数将调整后的文件写入指定目录。在这里我们得到了“福国论”,它被称为“福国论”,值得一提。同年,在乾隆皇帝在全国推行“销书以正人心”等文化调控政策之时,东西方的横向对比让人感慨万千。

以上是一个小测试。在为自己准备了一份精神食粮《富国论》之后,就可以开始尝试捕捉一些更难的数据了。股票应该是很多人在学习数据挖掘的道路上经常幻想的突破口。不幸的是,大多数人在这里崩溃了。他们虽然没能完成预测行情的重任,但也锻炼了自己的个人本领。既然这条路留下了很多“先贤”的足迹,我们不妨在这里抢股数据。如果你的梦想成真了怎么办?

East 发布了大量股票数据。用这个宝来捕捉他们关于“中国梦”的股票交易数据也是一个不错的选择。据我所知,市场中隐藏着一大块老股民表示,龙虎板的机构交易数据往往可以预测未来的股票走势。机构看好,后者崛起,机构跑路,有可能成为挑剔者。我建议你不要相应地投资。以上是不负责任的言论。你不必认真对待它。成功捕获数据是本书的责任。

###HTML 格式

lhb

复制代码

首先解释一下URL“,”是东方财富网龙虎帮的数据; `600006`是股票代码,指的是东风汽车,可以用任何已知的股票代码替换,龙虎名单数据每天收盘后更新,读者可以根据需要抓取; `html`表示网页数据为超文本标记语言格式。

不得不说一下`html`的基本内容,它是一种描述和构造数据的语言。要在网页上显示数据,不仅要标记某个部分是什么文件,例如图片、音频、视频、文本等,还要标记它们的归属关系。这就是 `html` 和 `xml` 所做的。在浏览器中右击,选择(Ctrl+U)“查看网页源代码”,查看网页的标记语言文本。

###简单的html结构

阳光灼伤我的心

导演:曹保平

主演:邓超/段奕宏/王珞丹/高虎

生产国家/地区:中国大陆

语言:普通话

发布日期:2015-08-27(中国大陆)

复制代码

`html` 一般分为头部和主体。 “和”之间描述了整个网页,包括网页的结构和标志等,“和”是网页的可见内容,`

`和`

`描述一个模块。树结构如下:

抓取网页音频(如何最高效地从海量信息里获取数据呢?(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 69 次浏览 • 2021-09-22 01:19

数据已进入各行各业并已被广泛使用,并且它是伴随着应用程序和数据的准确的挖掘。我们可以从内部repositorys和外部的载体,内部数据集成应用更多的数据和外部数据需要第一次。外部数据的最大矢量是因特网。在网页上,我们很难在增量数据,其中收录了我们很多信息,利用价值来算。

如何最有效地获取从海量的信息数据?卷筒纸原料工具@ @优采云采集器有高招,使用自动化的智能工具代替人工数据采集,当然,更有效的是更精确的。

一、数据用的通通

作为一个一般的网络抓取工具,@ @优采云采集器 @@ 采集器 @@ 采集器基操作操作操作操作让让网取网功能,,验证码识别,IP代理等网站采集ķ措;所捕获的对象的格式可以是文本,图片,音频,文件等,不再重复操作,轻松地将数据装入胶囊。

采集器2 @数据数据高的高高

高效是用于数据应用的另一个重要的吸引力,和信息爆炸式增长。如果你不能与速度跟不上,你会错过数据利用的最佳节点,所以它是数据采集的效率非常高。在过去,我们手动@采集数据,一百数据和网络捕获工具稳定在每天10万级,是几百倍的手工@采集。

采集器3 @Derating精度

有关的信息很长的时间可能会产生疲劳,而且软件标识可以继续肉眼辨别出要高精度地提取。然而,应该指出的是,@采集不同类型@ 网站或数据,@ @优采云采集器 @@ 采集器配置规则是不同的,并且可以仅由特定的条件,以保证高精度。

应对大数据时代的呼唤,注重数据资源,充分利用网络的抓取工具,并轻松集成胶囊,实现高利用数据资产和价值的价值! 查看全部

抓取网页音频(如何最高效地从海量信息里获取数据呢?(组图))

数据已进入各行各业并已被广泛使用,并且它是伴随着应用程序和数据的准确的挖掘。我们可以从内部repositorys和外部的载体,内部数据集成应用更多的数据和外部数据需要第一次。外部数据的最大矢量是因特网。在网页上,我们很难在增量数据,其中收录了我们很多信息,利用价值来算。

如何最有效地获取从海量的信息数据?卷筒纸原料工具@ @优采云采集器有高招,使用自动化的智能工具代替人工数据采集,当然,更有效的是更精确的。

一、数据用的通通

作为一个一般的网络抓取工具,@ @优采云采集器 @@ 采集器 @@ 采集器基操作操作操作操作让让网取网功能,,验证码识别,IP代理等网站采集ķ措;所捕获的对象的格式可以是文本,图片,音频,文件等,不再重复操作,轻松地将数据装入胶囊。

采集器2 @数据数据高的高高

高效是用于数据应用的另一个重要的吸引力,和信息爆炸式增长。如果你不能与速度跟不上,你会错过数据利用的最佳节点,所以它是数据采集的效率非常高。在过去,我们手动@采集数据,一百数据和网络捕获工具稳定在每天10万级,是几百倍的手工@采集。

采集器3 @Derating精度

有关的信息很长的时间可能会产生疲劳,而且软件标识可以继续肉眼辨别出要高精度地提取。然而,应该指出的是,@采集不同类型@ 网站或数据,@ @优采云采集器 @@ 采集器配置规则是不同的,并且可以仅由特定的条件,以保证高精度。

应对大数据时代的呼唤,注重数据资源,充分利用网络的抓取工具,并轻松集成胶囊,实现高利用数据资产和价值的价值!

抓取网页音频( Python修炼之道400页17w+字,目录如下! )

网站优化 • 优采云 发表了文章 • 0 个评论 • 79 次浏览 • 2021-09-10 23:13

Python修炼之道400页17w+字,目录如下!

)

4、如何获取cookies?

右击检查,找到网络,然后复制一个cookie:

/5 项目实现/

1、定义一个类继承对象,定义init方法继承self,main函数main继承self。导入需要的库和URL,代码如下。

import requestsfrom lxml import etreefrom fake_useragent import UserAgentimport sslclass Panda(object): def __init__(self): pass def main(self): passif __name__ == '__main__': imageSpider = Panda() imageSpider.main()

2、Import URL 并构造请求头。

self.url = "https://www.tukuppt.com/yinxia ... _0_0_{}.html" #/zhuanchang/:搜索的名字的拼音缩写 self.headers = { "User-Agent": "Mozilla/5.0 (Macintosh; Intel Mac OS X 10_11_6) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/70.0.3538.77 Safari/537.36" }

3、发送请求获取响应,页面回调,方便下次请求。

def get_page(self, url): res = requests.get(url=url, headers=self.headers) html = res.content.decode("utf-8") return html

4、xpath 解析页面数据。

这里先获取父节点,通过for循环遍历找到对应的子节点(音效地址)。

one = parse_html.xpath('//div[@]//dl') for li in one: lis_imges = li.xpath(".//audio//source/@src")[0].strip() who = li.xpath(".//dt//a/text()")[0].strip()

获取后发现地址代表完整地址,需要填写网站才能获取实际地址。

mp3 = "https:" + lis_imges

5、运行的结果,如下图:

6、请求音效地址,获取音效a标签对应的text()作为名称,写入文件。

dirname = "./音效/" + who + '.mp3'html2 = requests.get(url=mp3, headers=self.headers).contentwith open(dirname, 'wb') as f: f.write(html2) print("\n%s下载成功" % who))

7、调用方法实现功能。

html = self.get_page(url)self.parse_page(html)

/6 效果展示/

1、点击绿色三角运行,进入起始页和结束页,如1和2,获取1页信息。

2、程序运行后,会在控制台显示结果,如下图。

3、本地保存运行结果,如下图。

4、双击文件播放。

/7 总结/

1、 不建议取太多数据,可能造成服务器负载,简单试一下。 2、本文基于Python网络爬虫,利用爬虫库去除登录限制,下载音效,保存在文档中。 3、 按照步骤实现它。实施的时候总会遇到各种各样的问题。不看高手,努力去更深入地理解它。 4、希望通过这个项目,让大家对HTTPS网站和去除ssl验证有一个大致的了解。

我把我的原创文章整理成一本电子书,名为《Python实践之道》。它有 400 页和 17w+ 个字。内容如下:

现在免费送给大家,在公众号后台回复修真道即可领取。

最后,我最近成立了一个读者交流群。想要加入的可以在公众号后台回复“加群”~

推荐阅读:爆肝整理 400 页 《Python 修炼之道》,高清电子书送给一直支持我的读者!打脸!这款百度的产品,良心的很不百度真香!我挖到了一款超级强大的 SQL 工具!这个插件,牛逼!

查看全部

抓取网页音频(

Python修炼之道400页17w+字,目录如下!

)

4、如何获取cookies?

右击检查,找到网络,然后复制一个cookie:

/5 项目实现/

1、定义一个类继承对象,定义init方法继承self,main函数main继承self。导入需要的库和URL,代码如下。

import requestsfrom lxml import etreefrom fake_useragent import UserAgentimport sslclass Panda(object): def __init__(self): pass def main(self): passif __name__ == '__main__': imageSpider = Panda() imageSpider.main()

2、Import URL 并构造请求头。

self.url = "https://www.tukuppt.com/yinxia ... _0_0_{}.html" #/zhuanchang/:搜索的名字的拼音缩写 self.headers = { "User-Agent": "Mozilla/5.0 (Macintosh; Intel Mac OS X 10_11_6) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/70.0.3538.77 Safari/537.36" }

3、发送请求获取响应,页面回调,方便下次请求。

def get_page(self, url): res = requests.get(url=url, headers=self.headers) html = res.content.decode("utf-8") return html

4、xpath 解析页面数据。

这里先获取父节点,通过for循环遍历找到对应的子节点(音效地址)。

one = parse_html.xpath('//div[@]//dl') for li in one: lis_imges = li.xpath(".//audio//source/@src")[0].strip() who = li.xpath(".//dt//a/text()")[0].strip()

获取后发现地址代表完整地址,需要填写网站才能获取实际地址。

mp3 = "https:" + lis_imges

5、运行的结果,如下图:

6、请求音效地址,获取音效a标签对应的text()作为名称,写入文件。

dirname = "./音效/" + who + '.mp3'html2 = requests.get(url=mp3, headers=self.headers).contentwith open(dirname, 'wb') as f: f.write(html2) print("\n%s下载成功" % who))

7、调用方法实现功能。

html = self.get_page(url)self.parse_page(html)

/6 效果展示/

1、点击绿色三角运行,进入起始页和结束页,如1和2,获取1页信息。

2、程序运行后,会在控制台显示结果,如下图。

3、本地保存运行结果,如下图。

4、双击文件播放。

/7 总结/

1、 不建议取太多数据,可能造成服务器负载,简单试一下。 2、本文基于Python网络爬虫,利用爬虫库去除登录限制,下载音效,保存在文档中。 3、 按照步骤实现它。实施的时候总会遇到各种各样的问题。不看高手,努力去更深入地理解它。 4、希望通过这个项目,让大家对HTTPS网站和去除ssl验证有一个大致的了解。

我把我的原创文章整理成一本电子书,名为《Python实践之道》。它有 400 页和 17w+ 个字。内容如下:

现在免费送给大家,在公众号后台回复修真道即可领取。

最后,我最近成立了一个读者交流群。想要加入的可以在公众号后台回复“加群”~

推荐阅读:爆肝整理 400 页 《Python 修炼之道》,高清电子书送给一直支持我的读者!打脸!这款百度的产品,良心的很不百度真香!我挖到了一款超级强大的 SQL 工具!这个插件,牛逼!

抓取网页音频(如何在手机App中的数据抓取得到App数据的作业)

网站优化 • 优采云 发表了文章 • 0 个评论 • 91 次浏览 • 2021-09-10 13:07

前两天,知识星球上的一个高尔夫球手要求分配一个任务来捕获应用程序数据,所以我一言不发地答应了。

效果图如下

我们过去常常在网络上抓取数据,我们很少在移动应用中抓取数据。那么我们如何抓取移动应用中的数据呢?一般我们使用抓包工具来抓数据。

常用的捕获工具是 Fiddles 和 Charles。今天主要讲一下Charles的使用。与 Fiddles 相比,Charles 更强大,更易于使用。所以一般我推荐使用 Charles

下载并安装 Charles

下载安装Charles然后破解Charles,这里是文章教程,我就不多说了

注意事项:

如果获取到的数据是乱码,需要在Charles的菜单栏中设置连接SSL证书==>proxy==>SSL代理设置==>添加443,如上图所示。那么当你实际在抓取数据的时候记得把这个关掉,以免获取数据。

使用查尔斯

这里直接放两张图给大家使用看看就明白了

我们一起来分析一下这个项目。

# 这里有点递归的意味

max_id = datas[-1]['publish_time_stamp']

if self.max_id != max_id:

self.max_id = max_id

self.request_data()

else:

print('数据抓取完毕!')

完整代码:

import requests

import time

import json

from dedao.ExeclUtils import ExeclUtils

import os

class dedao(object):

def __init__(self):

# self.rows_title = [u'招聘标题', u'公司名称', u'公司地址', u'待遇', u'发布日期', u'招聘链接', u'招聘要求描述']

# sheet_name = u'51job_Python招聘'

self.rows_title = [u'来源目录', u'标题', u'图片', u'分享标题', u'mp3地址', u'音频时长', u'文件大小']

sheet_name = u'逻辑思维音频'

return_execl = ExeclUtils.create_execl(sheet_name, self.rows_title)

self.execl_f = return_execl[0]

self.sheet_table = return_execl[1]

self.audio_info = [] # 存放每一条数据中的各元素,

self.count = 0 # 数据插入从1开始的

self.base_url = 'https://entree.igetget.com/acr ... 27%3B

self.max_id = 0

self.headers = {

'Host': 'entree.igetget.com',

'X-OS': 'iOS',

'X-NET': 'wifi',

'Accept': '*/*',

'X-Nonce': '779b79d1d51d43fa',

'Accept-Encoding': 'br, gzip, deflate',

# 'Content-Length': ' 67',

'X-TARGET': 'main',

'User-Agent': '%E5%BE%97%E5%88%B0/4.0.13 CFNetwork/901.1 Darwin/17.6.0',

'X-CHIL': 'appstore',

'Cookie ': 'acw_tc=AQAAAC0YfiuHegUAxkvoZRLraUMQyRfH; aliyungf_tc=AQAAAKwCD1dINAUAxkvoZTppW+jezS/9',

'X-UID': '34556154',

'X-AV ': '4.0.0',

'X-SEID ': '',

'X-SCR ': '1242*2208',

'X-DT': 'phone',

'X-S': '91a46b7a31ffc7a2',

'X-Sign': 'ZTBiZjQyNTI1OTU2MTgwZjYwMWRhMjc5ZjhmMGRlNGI=',

'Accept-Language': 'zh-cn',

'X-D': 'ca3c83fca6e84a2d869f95829964ebb8',

'X-THUMB': 'l',

'X-T': 'json',

'X-Timestamp': '1528195376',

'X-TS': '1528195376',

'X-U': '34556154',

'X-App-Key': 'ios-4.0.0',

'X-OV': '11.4',

'Connection': 'keep-alive',

'X-ADV': '1',

'Content-Type': 'application/x-www-form-urlencoded',

'X-V': '2',

'X-IS_JAILBREAK ': 'NO',

'X-DV': 'iPhone10,2',

}

def request_data(self):

try:

data = {

'max_id': self.max_id,

'since_id': 0,

'column_id': 2,

'count': 20,

'order': 1,

'section': 0

}

response = requests.post(self.base_url, headers=self.headers, data=data)

if 200 == response.status_code:

self.parse_data(response)

except Exception as e:

print(e)

time.sleep(2)

pass

def parse_data(self, response):

dict_json = json.loads(response.text)

datas = dict_json['c']['list'] # 这里取得数据列表

# print(datas)

for data in datas:

source_name = data['audio_detail']['source_name']

title = data['audio_detail']['title']

icon = data['audio_detail']['icon']

share_title = data['audio_detail']['share_title']

mp3_url = data['audio_detail']['mp3_play_url']

duction = str(data['audio_detail']['duration']) + '秒'

size = data['audio_detail']['size'] / (1000 * 1000)

size = '%.2fM' % size

self.download_mp3(mp3_url)

self.audio_info.append(source_name)

self.audio_info.append(title)

self.audio_info.append(icon)

self.audio_info.append(share_title)

self.audio_info.append(mp3_url)

self.audio_info.append(duction)

self.audio_info.append(size)

self.count = self.count + 1

ExeclUtils.write_execl(self.execl_f, self.sheet_table, self.count, self.audio_info, u'逻辑思维音频.xlsx')

print('采集了{}条数据'.format(self.count))

# 清空集合,为再次存放数据做准备

self.audio_info = []

time.sleep(3) # 不要请求太快, 小心查水表

max_id = datas[-1]['publish_time_stamp']

if self.max_id != max_id:

self.max_id = max_id

self.request_data()

else:

print('数据抓取完毕!')

pass

def download_mp3(self, mp3_url):

try:

# 补全文件目录

mp3_path = u'D:/store/mp3/{}'.format(mp3_url.split('/')[-1])

print(mp3_path)

# 判断文件是否存在。

if not os.path.exists(mp3_path):

# 注意这里是写入文件,要用二进制格式写入。

with open(mp3_path, 'wb') as f:

f.write(requests.get(mp3_url).content)

except Exception as e:

print(e)

if __name__ == '__main__':

d = dedao()

d.request_data()

目前,这只是一个相对简单的移动应用数据捕获。如何操作更复杂的数据采集?如何抓取朋友圈的数据?如何抓取微信公众号数据?敬请期待! 查看全部

抓取网页音频(如何在手机App中的数据抓取得到App数据的作业)

前两天,知识星球上的一个高尔夫球手要求分配一个任务来捕获应用程序数据,所以我一言不发地答应了。

效果图如下

我们过去常常在网络上抓取数据,我们很少在移动应用中抓取数据。那么我们如何抓取移动应用中的数据呢?一般我们使用抓包工具来抓数据。

常用的捕获工具是 Fiddles 和 Charles。今天主要讲一下Charles的使用。与 Fiddles 相比,Charles 更强大,更易于使用。所以一般我推荐使用 Charles

下载并安装 Charles

下载安装Charles然后破解Charles,这里是文章教程,我就不多说了

注意事项:

如果获取到的数据是乱码,需要在Charles的菜单栏中设置连接SSL证书==>proxy==>SSL代理设置==>添加443,如上图所示。那么当你实际在抓取数据的时候记得把这个关掉,以免获取数据。

使用查尔斯

这里直接放两张图给大家使用看看就明白了

我们一起来分析一下这个项目。

# 这里有点递归的意味

max_id = datas[-1]['publish_time_stamp']

if self.max_id != max_id:

self.max_id = max_id

self.request_data()

else:

print('数据抓取完毕!')

完整代码:

import requests

import time

import json

from dedao.ExeclUtils import ExeclUtils

import os

class dedao(object):

def __init__(self):

# self.rows_title = [u'招聘标题', u'公司名称', u'公司地址', u'待遇', u'发布日期', u'招聘链接', u'招聘要求描述']

# sheet_name = u'51job_Python招聘'

self.rows_title = [u'来源目录', u'标题', u'图片', u'分享标题', u'mp3地址', u'音频时长', u'文件大小']

sheet_name = u'逻辑思维音频'

return_execl = ExeclUtils.create_execl(sheet_name, self.rows_title)

self.execl_f = return_execl[0]

self.sheet_table = return_execl[1]

self.audio_info = [] # 存放每一条数据中的各元素,

self.count = 0 # 数据插入从1开始的

self.base_url = 'https://entree.igetget.com/acr ... 27%3B

self.max_id = 0

self.headers = {

'Host': 'entree.igetget.com',

'X-OS': 'iOS',

'X-NET': 'wifi',

'Accept': '*/*',

'X-Nonce': '779b79d1d51d43fa',

'Accept-Encoding': 'br, gzip, deflate',

# 'Content-Length': ' 67',

'X-TARGET': 'main',

'User-Agent': '%E5%BE%97%E5%88%B0/4.0.13 CFNetwork/901.1 Darwin/17.6.0',

'X-CHIL': 'appstore',

'Cookie ': 'acw_tc=AQAAAC0YfiuHegUAxkvoZRLraUMQyRfH; aliyungf_tc=AQAAAKwCD1dINAUAxkvoZTppW+jezS/9',

'X-UID': '34556154',

'X-AV ': '4.0.0',

'X-SEID ': '',

'X-SCR ': '1242*2208',

'X-DT': 'phone',

'X-S': '91a46b7a31ffc7a2',

'X-Sign': 'ZTBiZjQyNTI1OTU2MTgwZjYwMWRhMjc5ZjhmMGRlNGI=',

'Accept-Language': 'zh-cn',

'X-D': 'ca3c83fca6e84a2d869f95829964ebb8',

'X-THUMB': 'l',

'X-T': 'json',

'X-Timestamp': '1528195376',

'X-TS': '1528195376',

'X-U': '34556154',

'X-App-Key': 'ios-4.0.0',

'X-OV': '11.4',

'Connection': 'keep-alive',

'X-ADV': '1',

'Content-Type': 'application/x-www-form-urlencoded',

'X-V': '2',

'X-IS_JAILBREAK ': 'NO',

'X-DV': 'iPhone10,2',

}

def request_data(self):

try:

data = {

'max_id': self.max_id,

'since_id': 0,

'column_id': 2,

'count': 20,

'order': 1,

'section': 0

}

response = requests.post(self.base_url, headers=self.headers, data=data)

if 200 == response.status_code:

self.parse_data(response)

except Exception as e:

print(e)

time.sleep(2)

pass

def parse_data(self, response):

dict_json = json.loads(response.text)

datas = dict_json['c']['list'] # 这里取得数据列表

# print(datas)

for data in datas:

source_name = data['audio_detail']['source_name']

title = data['audio_detail']['title']

icon = data['audio_detail']['icon']

share_title = data['audio_detail']['share_title']

mp3_url = data['audio_detail']['mp3_play_url']

duction = str(data['audio_detail']['duration']) + '秒'

size = data['audio_detail']['size'] / (1000 * 1000)

size = '%.2fM' % size

self.download_mp3(mp3_url)

self.audio_info.append(source_name)

self.audio_info.append(title)

self.audio_info.append(icon)

self.audio_info.append(share_title)

self.audio_info.append(mp3_url)

self.audio_info.append(duction)

self.audio_info.append(size)

self.count = self.count + 1

ExeclUtils.write_execl(self.execl_f, self.sheet_table, self.count, self.audio_info, u'逻辑思维音频.xlsx')

print('采集了{}条数据'.format(self.count))

# 清空集合,为再次存放数据做准备

self.audio_info = []

time.sleep(3) # 不要请求太快, 小心查水表

max_id = datas[-1]['publish_time_stamp']

if self.max_id != max_id:

self.max_id = max_id

self.request_data()

else:

print('数据抓取完毕!')

pass

def download_mp3(self, mp3_url):

try:

# 补全文件目录

mp3_path = u'D:/store/mp3/{}'.format(mp3_url.split('/')[-1])

print(mp3_path)

# 判断文件是否存在。

if not os.path.exists(mp3_path):

# 注意这里是写入文件,要用二进制格式写入。

with open(mp3_path, 'wb') as f:

f.write(requests.get(mp3_url).content)

except Exception as e:

print(e)

if __name__ == '__main__':

d = dedao()

d.request_data()

目前,这只是一个相对简单的移动应用数据捕获。如何操作更复杂的数据采集?如何抓取朋友圈的数据?如何抓取微信公众号数据?敬请期待!

抓取网页音频(网页上的“下载”往往会提示你下载APP直接获取一段音频)

网站优化 • 优采云 发表了文章 • 0 个评论 • 170 次浏览 • 2021-09-09 10:12

情况描述

在网上冲浪时,有时会遇到想要获取的音乐或音频文件,但碰巧访问的网页是例如某个云网页版本。在网页上点击“下载”经常会提示下载某个app,很烦,同时又想保存音频,怎么办?

网页音视频加载逻辑

对于这些小音乐网页版,其实是(或者一般来说)你播放它,服务器给你发送一个你实际访问的音视频的数据包。所以在这种情况下,根本不需要尝试从应用程序下载,只需要一个浏览器。

使用浏览器直接下载小音频(示例)

例如,我真的很喜欢六级聆听音频:

如果您点击“下载”,您会发现:

死了,但我还是想直接下载音频。

我使用的是谷歌Chrome浏览器,点击F12,点击网络,然后刷新页面,然后再次开始播放这个音频:

播放开始后,发现数据流突然加了一小段,同时缓冲条也加了一段。相关程度很明显,这个数据流估计就是我们想要的了。

点一下,没错,大家都知道.m4a是音频文件。所以如果我们复制Request Url的链接,在地址栏中访问,就可以直接通过浏览器访问整个音频文件了:

好的,点击这里立即下载。不管是什么网页版的音乐软件,不用下载APP就可以直接用这个技巧获取一段音频(当然你也有可能失去享受SQ的机会)

希望对大家有帮助! 查看全部

抓取网页音频(网页上的“下载”往往会提示你下载APP直接获取一段音频)

情况描述

在网上冲浪时,有时会遇到想要获取的音乐或音频文件,但碰巧访问的网页是例如某个云网页版本。在网页上点击“下载”经常会提示下载某个app,很烦,同时又想保存音频,怎么办?

网页音视频加载逻辑

对于这些小音乐网页版,其实是(或者一般来说)你播放它,服务器给你发送一个你实际访问的音视频的数据包。所以在这种情况下,根本不需要尝试从应用程序下载,只需要一个浏览器。

使用浏览器直接下载小音频(示例)

例如,我真的很喜欢六级聆听音频:

如果您点击“下载”,您会发现:

死了,但我还是想直接下载音频。

我使用的是谷歌Chrome浏览器,点击F12,点击网络,然后刷新页面,然后再次开始播放这个音频:

播放开始后,发现数据流突然加了一小段,同时缓冲条也加了一段。相关程度很明显,这个数据流估计就是我们想要的了。

点一下,没错,大家都知道.m4a是音频文件。所以如果我们复制Request Url的链接,在地址栏中访问,就可以直接通过浏览器访问整个音频文件了:

好的,点击这里立即下载。不管是什么网页版的音乐软件,不用下载APP就可以直接用这个技巧获取一段音频(当然你也有可能失去享受SQ的机会)

希望对大家有帮助!

抓取网页音频(一下R和python抓取数据的技术分工(一) )

网站优化 • 优采云 发表了文章 • 0 个评论 • 140 次浏览 • 2021-09-09 08:06

)

获取信息的能力往往是个人或组织取得成就的关键。从二战时期的恩格玛密码开始,人类进入了信息时代,信息开始在各个领域发挥越来越大的作用,甚至成为独立于其他资源的一种资源。

数据分析挖掘人员除了研究公司自身的数据外,还必须能够获取外部公开数据和二手数据,更加注重内外部数据的结合。聪明的女人不做饭是很难做饭的。当自身数据资源稀缺时,必须具备获取外部数据的能力,帮助企业和个人做出决策。不走在前面,我就去山里挖矿。在本章中,我们将重点学习R和python捕获数据的技术。

>获取信息的能力与其他专业技能一样重要。在深度分工的社会中,我们必须更加注重信息的广度。

复制代码

首先,我们来看看 R 来捕获常见的网络数据。要捕获数据,我们必须首先虚拟化一个命令行浏览器。 `RCurl` 包是 R 语言的命令行浏览器; `XML` 包用于解析和处理。浏览器接收到的 XML 或 HTML 数据;数据解析完成后,还需要做一些数据整理工作。 `stringr` 是处理字符数据的最佳选择。

###加载数据包

if (!suppressWarnings(require(RCurl))) {

install.packages("RCurl")

需要(RCurl)

}

if (!suppressWarnings(require(XML))) {

install.packages("XML")

要求(XML)

}

if (!suppressWarnings(require(stringr))) {

install.packages("stringr")

要求(字符串)

}

复制代码

在捕获数据之前,您需要了解网络数据的格式。网络数据一般包括文本、表格、超文本标记语言(HTML)、JSON等,以及获取数据时是否有权限限制等。事先清楚了解,一方面为了选择合适的捕获另一方面,如果有错误或困难,您可以详细描述您的问题,以便其他人可以提供帮助。

按照分步介绍的方法。首先,从简单地阅读文本格式的网页文本开始,然后从古腾堡 (``) 中获取一份“国富论的性质和原因的调查”。 ,这本书的名字直译为《国民财富的性质和原因的研究》,他还有一个更响亮的名字,《致富论》。世人尊称亚当·斯密为“现代经济学之父”和“自由企业的守护神”,人类第一次认识了看不见的手(`invisible hand`)。无形之手在不知不觉中引导自私的人类谋求自己的利益。在促进全人类利益发展的同时,今天我们将用R来捕捉这本书的全部内容,以纪念这位人类精英。

###读取文本数据

url fuguolun temp write.table(temp, "G:/zimeiti/dzdata/fuguolun.txt")

复制代码

直接使用R基础包中的`readLines`函数完整阅读“傅国伦”理论。 `readLines`有很多参数,最有用的是`n`和`encoding`两个参数,前者用于指定读取文本的前几行,后者用于指定文本的字符编码。另外,`readLines`函数读取的结果是一个列表对象,文本的每一行(注意:文本中的一行字符代表我们正在谈论的内容)都是列表的一个元素。

如果直接把list输出为txt,R会在每段开头加上list元素的编号,不符合电子书的格式,所以需要将它们合并成一定的格式,例如对每一行使用换行符。可以使用“粘贴”功能将它们粘合在一起。注意粘贴函数的两个参数sep和collapse,是用来设置用什么分隔符来分隔粘贴的。用法略有不同。如果要将`vector` 对象粘合在一起,以逗号分隔,请设置`sep = ","` 而不是设置`collapse`,如果要将`list` 对象粘合在一起,请使用`collapse = "," `.这里是后者,但选择的分隔符是`\n`。

然后使用`write.table`函数将调整后的文件写入指定目录。在这里我们得到了“福国论”,它被称为“福国论”,值得一提。同年,在乾隆皇帝在全国推行“销书以正人心”等文化调控政策之时,东西方的横向对比让人感慨万千。

以上是一个小测试。在为自己准备了一份精神食粮《富国论》之后,就可以开始尝试捕捉一些更难的数据了。股票应该是很多人在学习数据挖掘的道路上经常幻想的突破口。不幸的是,大多数人在这里崩溃了。他们虽然没能完成预测行情的重任,但也锻炼了自己的个人本领。既然这条路留下了很多“先贤”的足迹,我们不妨在这里抢股数据。如果你的梦想成真了怎么办?

East 发布了大量股票数据。用这个宝来捕捉他们关于“中国梦”的股票交易数据也是一个不错的选择。据我所知,市场中隐藏着一大块老股民表示,龙虎板的机构交易数据往往可以预测未来的股票走势。机构看好,后者崛起,机构跑路,有可能成为挑剔者。我建议你不要相应地投资。以上是不负责任的言论。你不必认真对待它。成功捕获数据是本书的责任。

###HTML 格式

lhb

复制代码

首先解释一下URL“,”是东方财富网龙虎帮的数据; `600006`是股票代码,指的是东风汽车,可以用任何已知的股票代码替换,龙虎名单数据每天收盘后更新,读者可以根据需要抓取; `html`表示网页数据为超文本标记语言格式。

不得不说一下`html`的基本内容,它是一种描述和构造数据的语言。要在网页上显示数据,不仅要标记某个部分是什么文件,例如图片、音频、视频、文本等,还要标记它们的归属关系。这就是 `html` 和 `xml` 所做的。在浏览器中右击,选择(Ctrl+U)“查看网页源代码”,查看网页的标记语言文本。

###简单的html结构

阳光灼伤我的心

导演:曹保平

主演:邓超/段奕宏/王珞丹/高虎

生产国家/地区:中国大陆

语言:普通话

发布日期:2015-08-27(中国大陆)

复制代码

`html` 一般分为头部和主体。 “和”之间描述了整个网页,包括网页的结构和标志等,“和”是网页的可见内容,`

`和`

`描述一个模块。树结构如下:

查看全部

抓取网页音频(一下R和python抓取数据的技术分工(一)

)

获取信息的能力往往是个人或组织取得成就的关键。从二战时期的恩格玛密码开始,人类进入了信息时代,信息开始在各个领域发挥越来越大的作用,甚至成为独立于其他资源的一种资源。

数据分析挖掘人员除了研究公司自身的数据外,还必须能够获取外部公开数据和二手数据,更加注重内外部数据的结合。聪明的女人不做饭是很难做饭的。当自身数据资源稀缺时,必须具备获取外部数据的能力,帮助企业和个人做出决策。不走在前面,我就去山里挖矿。在本章中,我们将重点学习R和python捕获数据的技术。

>获取信息的能力与其他专业技能一样重要。在深度分工的社会中,我们必须更加注重信息的广度。

复制代码

首先,我们来看看 R 来捕获常见的网络数据。要捕获数据,我们必须首先虚拟化一个命令行浏览器。 `RCurl` 包是 R 语言的命令行浏览器; `XML` 包用于解析和处理。浏览器接收到的 XML 或 HTML 数据;数据解析完成后,还需要做一些数据整理工作。 `stringr` 是处理字符数据的最佳选择。

###加载数据包

if (!suppressWarnings(require(RCurl))) {

install.packages("RCurl")

需要(RCurl)

}

if (!suppressWarnings(require(XML))) {

install.packages("XML")

要求(XML)

}

if (!suppressWarnings(require(stringr))) {

install.packages("stringr")

要求(字符串)

}

复制代码

在捕获数据之前,您需要了解网络数据的格式。网络数据一般包括文本、表格、超文本标记语言(HTML)、JSON等,以及获取数据时是否有权限限制等。事先清楚了解,一方面为了选择合适的捕获另一方面,如果有错误或困难,您可以详细描述您的问题,以便其他人可以提供帮助。

按照分步介绍的方法。首先,从简单地阅读文本格式的网页文本开始,然后从古腾堡 (``) 中获取一份“国富论的性质和原因的调查”。 ,这本书的名字直译为《国民财富的性质和原因的研究》,他还有一个更响亮的名字,《致富论》。世人尊称亚当·斯密为“现代经济学之父”和“自由企业的守护神”,人类第一次认识了看不见的手(`invisible hand`)。无形之手在不知不觉中引导自私的人类谋求自己的利益。在促进全人类利益发展的同时,今天我们将用R来捕捉这本书的全部内容,以纪念这位人类精英。

###读取文本数据

url fuguolun temp write.table(temp, "G:/zimeiti/dzdata/fuguolun.txt")

复制代码

直接使用R基础包中的`readLines`函数完整阅读“傅国伦”理论。 `readLines`有很多参数,最有用的是`n`和`encoding`两个参数,前者用于指定读取文本的前几行,后者用于指定文本的字符编码。另外,`readLines`函数读取的结果是一个列表对象,文本的每一行(注意:文本中的一行字符代表我们正在谈论的内容)都是列表的一个元素。

如果直接把list输出为txt,R会在每段开头加上list元素的编号,不符合电子书的格式,所以需要将它们合并成一定的格式,例如对每一行使用换行符。可以使用“粘贴”功能将它们粘合在一起。注意粘贴函数的两个参数sep和collapse,是用来设置用什么分隔符来分隔粘贴的。用法略有不同。如果要将`vector` 对象粘合在一起,以逗号分隔,请设置`sep = ","` 而不是设置`collapse`,如果要将`list` 对象粘合在一起,请使用`collapse = "," `.这里是后者,但选择的分隔符是`\n`。

然后使用`write.table`函数将调整后的文件写入指定目录。在这里我们得到了“福国论”,它被称为“福国论”,值得一提。同年,在乾隆皇帝在全国推行“销书以正人心”等文化调控政策之时,东西方的横向对比让人感慨万千。

以上是一个小测试。在为自己准备了一份精神食粮《富国论》之后,就可以开始尝试捕捉一些更难的数据了。股票应该是很多人在学习数据挖掘的道路上经常幻想的突破口。不幸的是,大多数人在这里崩溃了。他们虽然没能完成预测行情的重任,但也锻炼了自己的个人本领。既然这条路留下了很多“先贤”的足迹,我们不妨在这里抢股数据。如果你的梦想成真了怎么办?

East 发布了大量股票数据。用这个宝来捕捉他们关于“中国梦”的股票交易数据也是一个不错的选择。据我所知,市场中隐藏着一大块老股民表示,龙虎板的机构交易数据往往可以预测未来的股票走势。机构看好,后者崛起,机构跑路,有可能成为挑剔者。我建议你不要相应地投资。以上是不负责任的言论。你不必认真对待它。成功捕获数据是本书的责任。

###HTML 格式

lhb

复制代码

首先解释一下URL“,”是东方财富网龙虎帮的数据; `600006`是股票代码,指的是东风汽车,可以用任何已知的股票代码替换,龙虎名单数据每天收盘后更新,读者可以根据需要抓取; `html`表示网页数据为超文本标记语言格式。

不得不说一下`html`的基本内容,它是一种描述和构造数据的语言。要在网页上显示数据,不仅要标记某个部分是什么文件,例如图片、音频、视频、文本等,还要标记它们的归属关系。这就是 `html` 和 `xml` 所做的。在浏览器中右击,选择(Ctrl+U)“查看网页源代码”,查看网页的标记语言文本。

###简单的html结构

阳光灼伤我的心

导演:曹保平

主演:邓超/段奕宏/王珞丹/高虎

生产国家/地区:中国大陆

语言:普通话

发布日期:2015-08-27(中国大陆)

复制代码

`html` 一般分为头部和主体。 “和”之间描述了整个网页,包括网页的结构和标志等,“和”是网页的可见内容,`

`和`

`描述一个模块。树结构如下: