抓取网页生成电子书

抓取网页生成电子书( AI社区搭建出所谓语言模型的前提是学习数据的原因)

网站优化 • 优采云 发表了文章 • 0 个评论 • 104 次浏览 • 2022-04-20 10:27

AI社区搭建出所谓语言模型的前提是学习数据的原因)

由大数据文摘出品

合辑:非、倪妮、什锦甜、钱天培

人工智能未来的一个主要应用将是构建可以从数据中学习然后生成原创内容的网络。这个思想已经在自然语言处理(NLP)领域得到了充分的应用,这也是为什么AI社区可以构建所谓的语言模型:语言模型的前提是学习文章@中的句子结构> 段落,从而生成新的内容。

在这个文章@>我想尝试生成类似于非常流行的加拿大说唱歌手德雷克(又名#6god)风格的说唱歌词,一定很有趣。

另外,我也想分享一下通用的机器学习项目流水线,因为我发现很多同学想做一些小项目,但是不知道从哪里开始。

获取数据

首先,我们开始采集 Drake 的音乐库。为了节省时间,我写了一个爬虫来抓取网络上的歌词。

import urllib.request as urllib2

from bs4 import BeautifulSoup

import pandas as pd

import re

from unidecode import unidecode

quote_page = 'http://metrolyrics.com/{}-lyrics-drake.html'

filename = 'drake-songs.csv'

songs = pd.read_csv(filename)

for index, row in songs.iterrows():

page = urllib2.urlopen(quote_page.format(row['song']))

soup = BeautifulSoup(page, 'html.parser')

verses = soup.find_all('p', attrs={'class': 'verse'})

lyrics = ''

for verse in verses:

text = verse.text.strip()

text = re.sub(r"\[.*\]\n", "", unidecode(text))

if lyrics == '':

lyrics = lyrics + text.replace('\n', '|-|')

else:

lyrics = lyrics + '|-|' + text.replace('\n', '|-|')

songs.at[index, 'lyrics'] = lyrics

print('saving {}'.format(row['song']))

songs.head()

print('writing to .csv')

songs.to_csv(filename, sep=',', encoding='utf-8')

我使用了一个著名的 Python 包 BeautifulSoup 来抓取网页。我使用了 Justin Yek 的教程,一个很棒的人,在五分钟内学会了如何使用它。说明一下,在上面的代码中,我在循环中使用了歌曲的数据格式,因为我提前定义了我想要获取的歌曲。

教程:

所有歌词都存储在DataFrame中

运行爬虫后,我得到了一个csv文件,将歌词存储在一个合适的结构中,接下来就是对数据进行预处理并构建模型。

型号介绍

现在让我们看看模型是如何生成文本的。这部分理解很重要,因为这是真正的干货。我将从模型设计和生成歌词模型中的关键组件开始,然后我们可以直接进入实现阶段。

构建语言模型主要有两种方式:

1.字符级模型,

2.词级模型。

两者的主要区别在于模型的输入和输出。接下来,我将解释这两个模型是如何工作的。

字符级模型

在字符级模型中,输入是一个字符序列种子(seed),模型负责预测下一个字符,然后使用种子+new_char组合生成下一个字符,以此类推。请注意,由于我们应该保持每个输入的长度相同,我们实际上是在输入的每次迭代中删除一个字符。我们可以看一个简单直观的例子:

字符级模型生成单词的迭代过程

在每次迭代中,模型根据给定的种子字符预测下一个最有可能生成的字符,或者使用条件概率找到概率 P(new_char|seed) 的最大值,其中 new_char 是一个字母表。

在这个例子中,字符表是指所有英文字母和空格的集合。 (注意,字母表可以收录不同的字母,具体取决于您的需要,主要取决于您生成的语言类型)。

词法模型

词汇级别模型与字符级别模型非常相似,但它用于生成下一个单词而不是一个字符。这是一个简单的例子来说明这一点:

图3.词汇级模型生成的迭代过程

现在在这个模型中,我们期待以单词为单位的下一个单词,而不是字符。因此,我们要找到概率 P(new_word|seed) 的最大值,其中 new_word 是任意词。

这里需要注意的是,我们在比字符级别更大的范围内进行搜索。在字符集模型中,我们只需要从字符表中查找大约 30 个字符,但是每次迭代搜索在词汇表级别的范围远大于这个数字,所以每次迭代运行速度较慢,但是由于我们生成了一个整体单词而不是一个字符,所以也不错。

关于词汇级别模型的最后一点是,我们可以通过在数据集中搜索独特词汇来生成更多样化的词汇(此步骤通常在数据预处理阶段完成)。由于词汇量可以无限大,我们其实有很多算法来提高词汇生成的性能,比如词嵌入,不过我可以在这个问题上再写一个文章@>。

本文文章@>主要关注字符级模型,因为它更容易实现和理解,也更容易转化为复杂的词法级模型。

数据预处理

对于字符级模型,我们将进行如下数据预处理:

1.标记字符

对于字符级模型,输入应该基于字符而不是字符串。所以,我们先把每一行歌词变成一个字符的集合。

2。定义字符表

在上一步中,我们得到了歌词中所有可能的字符,现在我们需要找到所有唯一的字符。由于整个数据集不大(只有140首歌曲),为简单起见,我只保留所有英文字母和一些特殊符号(如空格),而忽略数字等信息(因为数据集很小,我宁愿让模型预测更少的字符)。

3.创建训练序列

这里我们将使用滑动窗口的概念。通过沿着句子拖动一个固定长度的窗口,我们将构建用于训练的数据序列。下图是滑动窗口操作的一个很好的例子:

图4.使用滑动窗口获取输入/输出

通过一次翻译一个字符,我们得到一个长度为 20 个字符的模型输入和一个长度为 1 个字符的模型输出。一次只转换一个网格的另一个好处是它极大地扩展了数据集的大小。

4.带注释的编码训练序列

最后,我们不想直接处理原创字符(虽然理论上每个字符都是一个数字,所以你也可以说 ASCII 已经为我们完成了每个字符的编码)。我们要做的就是用一个唯一的数字与每个字符一一对应,这一步就是所谓的标签编码。同时,我们要建立两个非常重要的映射:character-to-index(字符到索引)和index-to-character(索引到字符)。通过这两个映射,我们可以将字母表中的任意一个字符编码成对应的数字,同样的,我们也可以解码模型输出的数字索引,得到对应的字符。

5.数据集的one-hot编码

因为我们使用的是分类数据,也就是说所有的字符都可以归为某一类,所以我们会将字符编码成输入列的形式。

当我们完成以上五个步骤后,我们就基本完成了,接下来我们只需要构建和训练模型即可。如果您想深入了解更多细节,这里是五个步骤的代码供参考。

3.建立模型

我们将使用循环神经网络 (RNN),更具体地说是长短期记忆 (LSTM) 网络,根据先前呈现的字符集预测下一个字符。如果这两个概念听起来不熟悉,我还提供了相关概念的快速复习:

RNN 快速回顾

通常,您看到的网络是一个网格,从许多点汇聚到一个输出。如下图:

图5.神经网络图

这里的神经网络是单点输入和单点输出。它适用于输入不连续的情况,因为输入的顺序不影响输出。但是在我们的例子中,输入字符的顺序很重要,因为顺序决定了对应的单词。

RNN可以接收连续输入,将前一个节点的输出作为参数输入到下一个节点,从而解决输入顺序问题。

图6.简单的RNN示意图

例如,基于序列 Tryna_keep_it_simple,提取的下一个字符应该是_。这正是我们希望我们的神经网络做的事情。神经网络的输入会是 T — > x, r -> x, n -> x... e-> x ,对应的输出字符是空格 y -> _ 。

LSTM 快速回顾

简单的 RNN 网络仍然存在一些问题,它不擅长将非常前端的单元格信息传递给后端单元格。例如,Tryna keep it simple 句子中的最后一个词 me 对我来说是一个挣扎,如果不回顾它之前出现的词(可能预测为 Baka、cat、potato 等),很难预测。

LSTM 可以很好地解决这个问题,它在每个单元格中存储了部分之前的事件信息(即之前的单词)。如下图:

图7. LSTM 图,取自 Andrew Ng 的深度学习课程

不仅传递了前一个单元格的输出a,而且收录前一个单元格的输入信息的c也作为下一个单元格的输入的一部分。这使 LSTM 能够更好地保留上下文信息,并且适用于语言建模预测。

编程建模

之前学过一点Keras,所以这次会用Keras作为框架来编程搭建模型。其实也可以选择自己搭建模型框架,不过这样会比较费时间。

# create sequential network, because we are passing activations

# down the network

model = Sequential()

# add LSTM layer

model.add(LSTM(128, input_shape=(maxlen, len(chars))))

# add Softmax layer to output one character

model.add(Dense(len(chars)))

model.add(Activation('softmax'))

# compile the model and pick the loss and optimizer

model.compile(loss='categorical_crossentropy', optimizer=RMSprop(lr=0.01))

# train the model

model.fit(x, y, batch_size=128, epochs=30)

从上图可以看出,我们构建了LSTM模型,使用了批处理,使用数据子集进行批量训练,而不是一次性输入所有数据,这样可以稍微提高训练速度。

4、生成歌词

训练完模型,我们来介绍下如何生成下一个字符。我们首先使用用户输入的简单字符串作为随机种子。接下来,我们使用种子作为网络的输入来预测下一个字符,并重复这个过程,直到我们生成一些新的歌词,类似于图 2 所示的歌词。

以下是生成歌词的一些示例。

注意:这些歌词均未经过审核,请在阅读时自行检查。

您可能会注意到某些生成的单词是无意义的,这是字符级模型的常见问题。这是因为输入序列经常在单词中间被截断,从而使神经网络模型能够学习并生成对其输入有意义但对我们来说看起来很奇怪的新单词。

这也是词法级模型可以解决的问题,但是对于仅用200行代码构建的模型,字符级模型达到的效果还是很可观的。

其他应用

此处演示的字符级模型的歌词预测功能可以扩展到其他更有用的应用程序。

例如,可以使用相同的原理来预测 iPhone 键盘上要输入的下一个单词。

图8.键盘输入预测下一个单词

想象一下,如果你构建一个高精度的 Python 语言模型,它不仅可以自动填写 关键词 或变量名,还可以填写大段代码,这将帮助程序员节省大量时间!

您可能还注意到文本中的代码不完整,并且缺少一些片段。请到我的 Github 了解更多详情并学习构建自己的项目模型。

Github 链接:

相关报道: 查看全部

抓取网页生成电子书(

AI社区搭建出所谓语言模型的前提是学习数据的原因)

由大数据文摘出品

合辑:非、倪妮、什锦甜、钱天培

人工智能未来的一个主要应用将是构建可以从数据中学习然后生成原创内容的网络。这个思想已经在自然语言处理(NLP)领域得到了充分的应用,这也是为什么AI社区可以构建所谓的语言模型:语言模型的前提是学习文章@中的句子结构> 段落,从而生成新的内容。

在这个文章@>我想尝试生成类似于非常流行的加拿大说唱歌手德雷克(又名#6god)风格的说唱歌词,一定很有趣。

另外,我也想分享一下通用的机器学习项目流水线,因为我发现很多同学想做一些小项目,但是不知道从哪里开始。

获取数据

首先,我们开始采集 Drake 的音乐库。为了节省时间,我写了一个爬虫来抓取网络上的歌词。

import urllib.request as urllib2

from bs4 import BeautifulSoup

import pandas as pd

import re

from unidecode import unidecode

quote_page = 'http://metrolyrics.com/{}-lyrics-drake.html'

filename = 'drake-songs.csv'

songs = pd.read_csv(filename)

for index, row in songs.iterrows():

page = urllib2.urlopen(quote_page.format(row['song']))

soup = BeautifulSoup(page, 'html.parser')

verses = soup.find_all('p', attrs={'class': 'verse'})

lyrics = ''

for verse in verses:

text = verse.text.strip()

text = re.sub(r"\[.*\]\n", "", unidecode(text))

if lyrics == '':

lyrics = lyrics + text.replace('\n', '|-|')

else:

lyrics = lyrics + '|-|' + text.replace('\n', '|-|')

songs.at[index, 'lyrics'] = lyrics

print('saving {}'.format(row['song']))

songs.head()

print('writing to .csv')

songs.to_csv(filename, sep=',', encoding='utf-8')

我使用了一个著名的 Python 包 BeautifulSoup 来抓取网页。我使用了 Justin Yek 的教程,一个很棒的人,在五分钟内学会了如何使用它。说明一下,在上面的代码中,我在循环中使用了歌曲的数据格式,因为我提前定义了我想要获取的歌曲。

教程:

所有歌词都存储在DataFrame中

运行爬虫后,我得到了一个csv文件,将歌词存储在一个合适的结构中,接下来就是对数据进行预处理并构建模型。

型号介绍

现在让我们看看模型是如何生成文本的。这部分理解很重要,因为这是真正的干货。我将从模型设计和生成歌词模型中的关键组件开始,然后我们可以直接进入实现阶段。

构建语言模型主要有两种方式:

1.字符级模型,

2.词级模型。

两者的主要区别在于模型的输入和输出。接下来,我将解释这两个模型是如何工作的。

字符级模型

在字符级模型中,输入是一个字符序列种子(seed),模型负责预测下一个字符,然后使用种子+new_char组合生成下一个字符,以此类推。请注意,由于我们应该保持每个输入的长度相同,我们实际上是在输入的每次迭代中删除一个字符。我们可以看一个简单直观的例子:

字符级模型生成单词的迭代过程

在每次迭代中,模型根据给定的种子字符预测下一个最有可能生成的字符,或者使用条件概率找到概率 P(new_char|seed) 的最大值,其中 new_char 是一个字母表。

在这个例子中,字符表是指所有英文字母和空格的集合。 (注意,字母表可以收录不同的字母,具体取决于您的需要,主要取决于您生成的语言类型)。

词法模型

词汇级别模型与字符级别模型非常相似,但它用于生成下一个单词而不是一个字符。这是一个简单的例子来说明这一点:

图3.词汇级模型生成的迭代过程

现在在这个模型中,我们期待以单词为单位的下一个单词,而不是字符。因此,我们要找到概率 P(new_word|seed) 的最大值,其中 new_word 是任意词。

这里需要注意的是,我们在比字符级别更大的范围内进行搜索。在字符集模型中,我们只需要从字符表中查找大约 30 个字符,但是每次迭代搜索在词汇表级别的范围远大于这个数字,所以每次迭代运行速度较慢,但是由于我们生成了一个整体单词而不是一个字符,所以也不错。

关于词汇级别模型的最后一点是,我们可以通过在数据集中搜索独特词汇来生成更多样化的词汇(此步骤通常在数据预处理阶段完成)。由于词汇量可以无限大,我们其实有很多算法来提高词汇生成的性能,比如词嵌入,不过我可以在这个问题上再写一个文章@>。

本文文章@>主要关注字符级模型,因为它更容易实现和理解,也更容易转化为复杂的词法级模型。

数据预处理

对于字符级模型,我们将进行如下数据预处理:

1.标记字符

对于字符级模型,输入应该基于字符而不是字符串。所以,我们先把每一行歌词变成一个字符的集合。

2。定义字符表

在上一步中,我们得到了歌词中所有可能的字符,现在我们需要找到所有唯一的字符。由于整个数据集不大(只有140首歌曲),为简单起见,我只保留所有英文字母和一些特殊符号(如空格),而忽略数字等信息(因为数据集很小,我宁愿让模型预测更少的字符)。

3.创建训练序列

这里我们将使用滑动窗口的概念。通过沿着句子拖动一个固定长度的窗口,我们将构建用于训练的数据序列。下图是滑动窗口操作的一个很好的例子:

图4.使用滑动窗口获取输入/输出

通过一次翻译一个字符,我们得到一个长度为 20 个字符的模型输入和一个长度为 1 个字符的模型输出。一次只转换一个网格的另一个好处是它极大地扩展了数据集的大小。

4.带注释的编码训练序列

最后,我们不想直接处理原创字符(虽然理论上每个字符都是一个数字,所以你也可以说 ASCII 已经为我们完成了每个字符的编码)。我们要做的就是用一个唯一的数字与每个字符一一对应,这一步就是所谓的标签编码。同时,我们要建立两个非常重要的映射:character-to-index(字符到索引)和index-to-character(索引到字符)。通过这两个映射,我们可以将字母表中的任意一个字符编码成对应的数字,同样的,我们也可以解码模型输出的数字索引,得到对应的字符。

5.数据集的one-hot编码

因为我们使用的是分类数据,也就是说所有的字符都可以归为某一类,所以我们会将字符编码成输入列的形式。

当我们完成以上五个步骤后,我们就基本完成了,接下来我们只需要构建和训练模型即可。如果您想深入了解更多细节,这里是五个步骤的代码供参考。

3.建立模型

我们将使用循环神经网络 (RNN),更具体地说是长短期记忆 (LSTM) 网络,根据先前呈现的字符集预测下一个字符。如果这两个概念听起来不熟悉,我还提供了相关概念的快速复习:

RNN 快速回顾

通常,您看到的网络是一个网格,从许多点汇聚到一个输出。如下图:

图5.神经网络图

这里的神经网络是单点输入和单点输出。它适用于输入不连续的情况,因为输入的顺序不影响输出。但是在我们的例子中,输入字符的顺序很重要,因为顺序决定了对应的单词。

RNN可以接收连续输入,将前一个节点的输出作为参数输入到下一个节点,从而解决输入顺序问题。

图6.简单的RNN示意图

例如,基于序列 Tryna_keep_it_simple,提取的下一个字符应该是_。这正是我们希望我们的神经网络做的事情。神经网络的输入会是 T — > x, r -> x, n -> x... e-> x ,对应的输出字符是空格 y -> _ 。

LSTM 快速回顾

简单的 RNN 网络仍然存在一些问题,它不擅长将非常前端的单元格信息传递给后端单元格。例如,Tryna keep it simple 句子中的最后一个词 me 对我来说是一个挣扎,如果不回顾它之前出现的词(可能预测为 Baka、cat、potato 等),很难预测。

LSTM 可以很好地解决这个问题,它在每个单元格中存储了部分之前的事件信息(即之前的单词)。如下图:

图7. LSTM 图,取自 Andrew Ng 的深度学习课程

不仅传递了前一个单元格的输出a,而且收录前一个单元格的输入信息的c也作为下一个单元格的输入的一部分。这使 LSTM 能够更好地保留上下文信息,并且适用于语言建模预测。

编程建模

之前学过一点Keras,所以这次会用Keras作为框架来编程搭建模型。其实也可以选择自己搭建模型框架,不过这样会比较费时间。

# create sequential network, because we are passing activations

# down the network

model = Sequential()

# add LSTM layer

model.add(LSTM(128, input_shape=(maxlen, len(chars))))

# add Softmax layer to output one character

model.add(Dense(len(chars)))

model.add(Activation('softmax'))

# compile the model and pick the loss and optimizer

model.compile(loss='categorical_crossentropy', optimizer=RMSprop(lr=0.01))

# train the model

model.fit(x, y, batch_size=128, epochs=30)

从上图可以看出,我们构建了LSTM模型,使用了批处理,使用数据子集进行批量训练,而不是一次性输入所有数据,这样可以稍微提高训练速度。

4、生成歌词

训练完模型,我们来介绍下如何生成下一个字符。我们首先使用用户输入的简单字符串作为随机种子。接下来,我们使用种子作为网络的输入来预测下一个字符,并重复这个过程,直到我们生成一些新的歌词,类似于图 2 所示的歌词。

以下是生成歌词的一些示例。

注意:这些歌词均未经过审核,请在阅读时自行检查。

您可能会注意到某些生成的单词是无意义的,这是字符级模型的常见问题。这是因为输入序列经常在单词中间被截断,从而使神经网络模型能够学习并生成对其输入有意义但对我们来说看起来很奇怪的新单词。

这也是词法级模型可以解决的问题,但是对于仅用200行代码构建的模型,字符级模型达到的效果还是很可观的。

其他应用

此处演示的字符级模型的歌词预测功能可以扩展到其他更有用的应用程序。

例如,可以使用相同的原理来预测 iPhone 键盘上要输入的下一个单词。

图8.键盘输入预测下一个单词

想象一下,如果你构建一个高精度的 Python 语言模型,它不仅可以自动填写 关键词 或变量名,还可以填写大段代码,这将帮助程序员节省大量时间!

您可能还注意到文本中的代码不完整,并且缺少一些片段。请到我的 Github 了解更多详情并学习构建自己的项目模型。

Github 链接:

相关报道:

抓取网页生成电子书(这款网络书籍器绿色版怎么拯救你的网上书籍下载工具?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 441 次浏览 • 2022-04-19 06:13

当你喜欢小说却下载不了的时候,你会不会觉得不舒服?别慌,这款网络图书采集器绿色版来救你了,作为一款简单好用的网络图书下载工具,本软件主要用于采集网络小说生成文本文件。您可以提取和调整指定小说目录页面的章节信息,然后按照章节顺序抓取小说内容,然后将它们合并在一起。并且爬取过程可以随时中断,程序关闭后可以继续上一个任务,不用担心意外原因导致的错误。而且,本站提供的在线图书抓取器绿色版无需安装。解压运行后即可使用,方便快捷。

特色1、章节调整

目录解压后,可以进行移动、删除、反转等调整操作。调整将直接影响最终的书籍和调整章节顺序的输出。

2、自动重试

在爬取过程中,可能会因为网络因素导致爬取失败。本程序可能会自动重试直到成功,或者暂时中断爬取(中断后关闭程序不会影响进度),等网络好后再试。

3、停止并恢复

抓取过程可以随时停止,退出程序后仍能保证进度(章节信息会保存在记录中,下次运行程序后即可恢复抓取。注意:需要退出程序前使用停止键中断程序,直接退出不会恢复)。

4、一键抓取

又称“傻瓜模式”,基本可以实现全自动抓取合并功能,直接输出最终的文本文件。前面可能需要输入最基本的 URL、save bit 等信息(会有明显的操作提示)。调整章节后也可以使用一键爬取,爬取和合并操作会自动完成。

5、适用网站

已录入10个适用的网站(选择后可快速打开网站找到需要的书籍),也可自动申请相应的代码,其他小说网站 也可以测试,如果一起使用,可以手动添加到设置文件中进行备份。

6、轻松制作电子书

每个章节名称的前缀和后缀都可以添加到设置文件中,为后期制作电子书的编目带来了极大的方便。使用方法1、点击本站下载解压。

2、点击应用打开。

3、进入要下载的小说网页,输入书名,点击目录解压。

4、设置保存路径,点击Start Grab开始下载。

Changelog Web Book Grabber v1.4 (2020-5-16)

1、优化界面体验。

2、修复了一些已知的错误。 查看全部

抓取网页生成电子书(这款网络书籍器绿色版怎么拯救你的网上书籍下载工具?)

当你喜欢小说却下载不了的时候,你会不会觉得不舒服?别慌,这款网络图书采集器绿色版来救你了,作为一款简单好用的网络图书下载工具,本软件主要用于采集网络小说生成文本文件。您可以提取和调整指定小说目录页面的章节信息,然后按照章节顺序抓取小说内容,然后将它们合并在一起。并且爬取过程可以随时中断,程序关闭后可以继续上一个任务,不用担心意外原因导致的错误。而且,本站提供的在线图书抓取器绿色版无需安装。解压运行后即可使用,方便快捷。

特色1、章节调整

目录解压后,可以进行移动、删除、反转等调整操作。调整将直接影响最终的书籍和调整章节顺序的输出。

2、自动重试

在爬取过程中,可能会因为网络因素导致爬取失败。本程序可能会自动重试直到成功,或者暂时中断爬取(中断后关闭程序不会影响进度),等网络好后再试。

3、停止并恢复

抓取过程可以随时停止,退出程序后仍能保证进度(章节信息会保存在记录中,下次运行程序后即可恢复抓取。注意:需要退出程序前使用停止键中断程序,直接退出不会恢复)。

4、一键抓取

又称“傻瓜模式”,基本可以实现全自动抓取合并功能,直接输出最终的文本文件。前面可能需要输入最基本的 URL、save bit 等信息(会有明显的操作提示)。调整章节后也可以使用一键爬取,爬取和合并操作会自动完成。

5、适用网站

已录入10个适用的网站(选择后可快速打开网站找到需要的书籍),也可自动申请相应的代码,其他小说网站 也可以测试,如果一起使用,可以手动添加到设置文件中进行备份。

6、轻松制作电子书

每个章节名称的前缀和后缀都可以添加到设置文件中,为后期制作电子书的编目带来了极大的方便。使用方法1、点击本站下载解压。

2、点击应用打开。

3、进入要下载的小说网页,输入书名,点击目录解压。

4、设置保存路径,点击Start Grab开始下载。

Changelog Web Book Grabber v1.4 (2020-5-16)

1、优化界面体验。

2、修复了一些已知的错误。

抓取网页生成电子书(web不再的攻防角度来讲程序是危害web原创生态的一大元凶)

网站优化 • 优采云 发表了文章 • 0 个评论 • 117 次浏览 • 2022-04-19 06:12

网络是一个开放的平台,它为网络从1990年代初诞生到今天的蓬勃发展奠定了基础。然而,所谓的成败也很小,开放的特性、搜索引擎、简单易学的html和css技术,让web成为了互联网领域最流行、最成熟的信息传播媒介;但是现在作为商业软件,web是平台上的内容信息的版权是不能保证的,因为与软件客户端相比,你的网页内容可以通过一些爬虫程序以非常低的成本实现,并且技术门槛很低,这也是本系列文章要讨论的——网络爬虫。

有很多人认为,网络应该始终遵循开放的精神,页面上呈现的信息应该毫无保留地与整个互联网共享。但是,我认为随着今天IT行业的发展,网络不再是当年与pdf竞争的所谓“超文本”信息载体。它已经基于轻量级客户端软件的思想。存在。随着商业软件的发展,网络也不得不面对知识产权保护的问题。试想一下,如果原创的优质内容不受保护,网络世界中抄袭盗版猖獗,这其实有利于网络生态的健康发展。这是一个缺点,而且它'

未经授权的爬虫程序是危害web原创内容生态的罪魁祸首。因此,为了保护网站的内容,首先要考虑如何反爬。

从爬行动物的攻防来看

最简单的爬虫是几乎所有服务器端和客户端编程语言都支持的 http 请求。只要对目标页面的url进行http get请求,就可以获得浏览器加载页面时的完整html文档。我们称之为“同步页面”。

作为防御方,服务器可以根据http请求头中的User-Agent检查客户端是合法的浏览器程序还是脚本爬虫,从而决定是否使用真实的页面信息内容发送给你。

这当然是儿科最小的防御方法。作为进攻方,爬虫完全可以伪造User-Agent字段。甚至,只要你愿意,在http的get方法中,请求头的Referrer、Cookie等所有字段都可以被爬虫轻松处理。伪造。

这时,服务器就可以根据你声明的浏览器厂商和版本(来自User-Agent),使用浏览器http头指纹来识别你http头中的每个字段是否符合浏览器的特性。如果匹配,它将被视为爬虫。该技术的一个典型应用是在 PhantomJS 1.x 版本中,由于底层调用了 Qt 框架的网络库,http 头具有明显的 Qt 框架的网络请求特征,可以服务器直接识别。并被拦截。

另外,还有一个比较异常的服务器端爬虫检测机制,就是在http响应中为所有访问该页面的http请求种上一个cookie token,然后在这个异步执行的一些ajax接口上学页。检查访问请求中是否收录cookie token,返回token表示这是一次合法的浏览器访问,否则表示刚刚发出token的用户访问了页面html但没有访问执行js后调用的ajax在 html 请求中,很可能是爬虫。

如果你不带token直接访问一个接口,说明你没有请求过html页面,而是直接向页面中应该通过ajax访问的接口发起网络请求,这显然证明你是一个可疑的爬虫。知名电子商务公司网站亚马逊采用了这种防御策略。

以上是基于服务器端验证爬虫程序可以玩的一些套路。

基于客户端js运行时的检测

现代浏览器赋予 JavaScript 强大的能力,所以我们可以将页面的所有核心内容作为 js 异步请求 ajax 获取数据然后渲染到页面中,这显然提高了爬取内容的门槛。这样,我们就将爬虫和反爬的战斗从服务端转移到了客户端浏览器中的js运行时。接下来说一下结合客户端js运行时的爬取技术。

刚才提到的各种服务器端验证,对于普通的python和java语言编写的HTTP爬虫程序,都有一定的技术门槛。毕竟,Web 应用程序是未经授权的抓取工具的黑匣子。很多东西都需要一点一点的去尝试,而一套耗费大量人力物力开发的爬虫程序,只要网站作为防御者可以轻松调整一些策略,攻击者也需要花费同样的时间再次修改爬虫的爬取逻辑。

此时,您需要使用无头浏览器。这是什么技术?其实说白了就是程序可以操作浏览器访问网页,这样写爬虫的人就可以通过调用浏览器暴露给程序的API来实现复杂的爬取业务逻辑。

事实上,这并不是近年来的新技术。曾经有基于webkit内核的PhantomJS,基于火狐浏览器内核的SlimerJS,甚至还有基于IE内核的trifleJS。如果你有兴趣,可以看看这里和这里有两个无头浏览器采集列表。

这些无头浏览器程序的原理其实就是对一些开源浏览器内核C++代码进行改造和封装,实现一个无需GUI界面渲染的简单浏览器程序。但是这些项目的通病是因为他们的代码是基于fork官方webkit和其他内核的某个版本的trunk代码,所以跟不上一些最新的css属性和js语法,还有一些兼容性问题,不如真实的GUI浏览器发行版运行稳定。

其中,最成熟、用得最多的应该是PhantonJS。之前写过一篇关于这种爬虫识别的博客,这里不再赘述。PhantomJS 有很多问题,因为它是单进程模型,没有必要的沙箱保护,浏览器内核的安全性较差。此外,该项目的作者已经宣布他们将停止维护这个项目。

现在谷歌浏览器团队已经在 Chrome 59 发布版本中开放了 headless mode api,并开源了一个基于 Node.js 调用的 headless chromium dirver 库。我还为这个库贡献了一个centos环境部署依赖安装列表。

Headless Chrome 可以说是 Headless Browser 中独一无二的杀手锏。由于它本身就是一个 chrome 浏览器,它支持各种新的 CSS 渲染特性和 js 运行时语法。

基于这种方法,爬虫作为攻击方可以绕过几乎所有的服务器端验证逻辑,但是这些爬虫在客户端js运行时仍然存在一些缺陷,例如:

基于插件对象的检查

if(navigator.plugins.length === 0) {

console.log('It may be Chrome headless');

}

复制代码

基于语言的检查

if(navigator.languages === '') {

console.log('Chrome headless detected');

}

复制代码

基于 webgl 的检查

var canvas = document.createElement('canvas');

var gl = canvas.getContext('webgl');

var debugInfo = gl.getExtension('WEBGL_debug_renderer_info');

var vendor = gl.getParameter(debugInfo.UNMASKED_VENDOR_WEBGL);

var renderer = gl.getParameter(debugInfo.UNMASKED_RENDERER_WEBGL);

if(vendor == 'Brian Paul' && renderer == 'Mesa OffScreen') {

console.log('Chrome headless detected');

}

复制代码

基于浏览器细线属性的检查

if(!Modernizr['hairline']) {

console.log('It may be Chrome headless');

}

复制代码

检查基于错误的img src属性生成的img对象

var body = document.getElementsByTagName('body')[0];

var image = document.createElement('img');

image.src = 'http://iloveponeydotcom32188.jg';

image.setAttribute('id', 'fakeimage');

body.appendChild(image);

image.onerror = function(){

if(image.width == 0 && image.height == 0) {

console.log('Chrome headless detected');

}

}

复制代码

基于以上一些浏览器特性的判断,它基本上可以秒杀市面上大部分的Headless Browser程序。在这个层面上,网页爬虫的门槛其实是提高了,要求编写爬虫程序的开发者不得不修改浏览器内核的C++代码,重新编译一个浏览器,而以上特性对浏览器来说是很重要的。内核的改动其实不小,如果你尝试过编译Blink内核或者Gecko内核你就会明白对于一个“脚本小子”来说是多么的难了~

此外,我们还可以根据浏览器的UserAgent字段中描述的浏览器品牌、版本、型号信息,检查js运行时、DOM和BOM的各个native对象的属性和方法,观察特性是否符合浏览器这个版本。设备应具备的功能。

这种方法称为浏览器指纹识别技术,它依赖于大型网站对各类浏览器的api信息的采集。作为编写爬虫程序的攻击者,你可以在无头浏览器运行时预先注入一些js逻辑来伪造浏览器的特性。

另外,在研究Robots Browser Detect using js api在浏览器端的时候,我们发现了一个有趣的trick。可以将预先注入的js函数伪装成Native Function,看一下下面的代码:

var fakeAlert = (function(){}).bind(null);

console.log(window.alert.toString()); // function alert() { [native code] }

console.log(fakeAlert.toString()); // function () { [native code] }

复制代码

爬虫攻击者可能会预先注入一些js方法,用一层代理函数作为钩子包裹一些原生api,然后用这个假的js api覆盖原生api。如果防御者在函数 toString 之后基于对 [native code] 的检查来检查这一点,它将被绕过。所以需要更严格的检查,因为bind(null) fake方法在toString之后没有函数名,所以需要检查toString之后的函数名是否为空。

这个技巧有什么用?在这里延伸一下,反爬虫防御者有一个Robot Detect方法,就是在js运行的时候主动抛出一个alert。文案可以写一些业务逻辑相关的。当普通用户点击OK按钮时,肯定会有1s甚至是alert。对于更长的延迟,由于浏览器中的alert会阻塞js代码的运行(其实在v8中,他会以类似进程挂起的方式挂起isolate context的执行),所以爬虫作为攻击者可以选择使用上面的窍门,就是在页面所有js运行前预先注入一段js代码,伪造alert、prompt、confirm等所有弹窗方法。如果防御者在弹出代码之前检查他调用的alert方法是否仍然是原生的,则这种方式被阻止。

对付爬行动物的灵丹妙药

目前最可靠的反爬虫和机器人巡检手段是验证码技术。但是,验证码并不意味着必须强制用户输入一系列字母数字。还有很多基于用户鼠标、触摸屏(移动端)等行为的行为验证技术。其中,最成熟的是基于机器学习的谷歌reCAPTCHA。区分用户和爬虫。

基于以上对用户和爬虫的识别和区分技术,网站的防御者需要做的就是对该IP地址进行封锁或者对该IP的访问用户施加高强度的验证码策略。这样攻击者就不得不购买IP代理池来捕获网站信息内容,否则单个IP地址很容易被封杀,无法被捕获。爬取和反爬取的门槛已经提升到IP代理池的经济成本水平。

机器人协议

此外,在爬虫爬取技术领域,还有一种叫做robots协议的“白道”方式。您可以访问 网站 根目录中的 /robots.txt。比如我们看一下github的robot协议。Allow 和 Disallow 声明每个 UA 爬虫的授权。

然而,这只是君子之约。虽然它有法律上的好处,但它只能限制那些商业搜索引擎的蜘蛛程序,你不能限制那些“野爬爱好者”。

写在最后

网页内容的爬取与对抗,注定是一场魔高道高的猫捉老鼠游戏。你永远不可能用某种技术完全挡住爬虫的去路,你能做的就是增加攻击。用户爬取的成本,以及关于未经授权的爬取行为的更准确信息。

这篇文章中提到的验证码攻防其实是一个比较复杂的技术难点。我在这里留下一个悬念。有兴趣的可以多加关注,期待后续文章的详细阐述。

另外,欢迎对爬虫感兴趣的朋友关注我的开源项目webster。该项目以Node.js结合Chrome无头模式实现了一个高可用的网络爬虫爬取框架。一个页面中js和ajax渲染的所有异步内容;结合redis,实现了一个任务队列,让爬虫轻松进行横向和纵向分布式扩展。很容易部署,我已经为webster提供了一个正式版的base runtime docker镜像,如果你想先睹为快,你也可以试试这个webster demo docker image。 查看全部

抓取网页生成电子书(web不再的攻防角度来讲程序是危害web原创生态的一大元凶)

网络是一个开放的平台,它为网络从1990年代初诞生到今天的蓬勃发展奠定了基础。然而,所谓的成败也很小,开放的特性、搜索引擎、简单易学的html和css技术,让web成为了互联网领域最流行、最成熟的信息传播媒介;但是现在作为商业软件,web是平台上的内容信息的版权是不能保证的,因为与软件客户端相比,你的网页内容可以通过一些爬虫程序以非常低的成本实现,并且技术门槛很低,这也是本系列文章要讨论的——网络爬虫。

有很多人认为,网络应该始终遵循开放的精神,页面上呈现的信息应该毫无保留地与整个互联网共享。但是,我认为随着今天IT行业的发展,网络不再是当年与pdf竞争的所谓“超文本”信息载体。它已经基于轻量级客户端软件的思想。存在。随着商业软件的发展,网络也不得不面对知识产权保护的问题。试想一下,如果原创的优质内容不受保护,网络世界中抄袭盗版猖獗,这其实有利于网络生态的健康发展。这是一个缺点,而且它'

未经授权的爬虫程序是危害web原创内容生态的罪魁祸首。因此,为了保护网站的内容,首先要考虑如何反爬。

从爬行动物的攻防来看

最简单的爬虫是几乎所有服务器端和客户端编程语言都支持的 http 请求。只要对目标页面的url进行http get请求,就可以获得浏览器加载页面时的完整html文档。我们称之为“同步页面”。

作为防御方,服务器可以根据http请求头中的User-Agent检查客户端是合法的浏览器程序还是脚本爬虫,从而决定是否使用真实的页面信息内容发送给你。

这当然是儿科最小的防御方法。作为进攻方,爬虫完全可以伪造User-Agent字段。甚至,只要你愿意,在http的get方法中,请求头的Referrer、Cookie等所有字段都可以被爬虫轻松处理。伪造。

这时,服务器就可以根据你声明的浏览器厂商和版本(来自User-Agent),使用浏览器http头指纹来识别你http头中的每个字段是否符合浏览器的特性。如果匹配,它将被视为爬虫。该技术的一个典型应用是在 PhantomJS 1.x 版本中,由于底层调用了 Qt 框架的网络库,http 头具有明显的 Qt 框架的网络请求特征,可以服务器直接识别。并被拦截。

另外,还有一个比较异常的服务器端爬虫检测机制,就是在http响应中为所有访问该页面的http请求种上一个cookie token,然后在这个异步执行的一些ajax接口上学页。检查访问请求中是否收录cookie token,返回token表示这是一次合法的浏览器访问,否则表示刚刚发出token的用户访问了页面html但没有访问执行js后调用的ajax在 html 请求中,很可能是爬虫。

如果你不带token直接访问一个接口,说明你没有请求过html页面,而是直接向页面中应该通过ajax访问的接口发起网络请求,这显然证明你是一个可疑的爬虫。知名电子商务公司网站亚马逊采用了这种防御策略。

以上是基于服务器端验证爬虫程序可以玩的一些套路。

基于客户端js运行时的检测

现代浏览器赋予 JavaScript 强大的能力,所以我们可以将页面的所有核心内容作为 js 异步请求 ajax 获取数据然后渲染到页面中,这显然提高了爬取内容的门槛。这样,我们就将爬虫和反爬的战斗从服务端转移到了客户端浏览器中的js运行时。接下来说一下结合客户端js运行时的爬取技术。

刚才提到的各种服务器端验证,对于普通的python和java语言编写的HTTP爬虫程序,都有一定的技术门槛。毕竟,Web 应用程序是未经授权的抓取工具的黑匣子。很多东西都需要一点一点的去尝试,而一套耗费大量人力物力开发的爬虫程序,只要网站作为防御者可以轻松调整一些策略,攻击者也需要花费同样的时间再次修改爬虫的爬取逻辑。

此时,您需要使用无头浏览器。这是什么技术?其实说白了就是程序可以操作浏览器访问网页,这样写爬虫的人就可以通过调用浏览器暴露给程序的API来实现复杂的爬取业务逻辑。

事实上,这并不是近年来的新技术。曾经有基于webkit内核的PhantomJS,基于火狐浏览器内核的SlimerJS,甚至还有基于IE内核的trifleJS。如果你有兴趣,可以看看这里和这里有两个无头浏览器采集列表。

这些无头浏览器程序的原理其实就是对一些开源浏览器内核C++代码进行改造和封装,实现一个无需GUI界面渲染的简单浏览器程序。但是这些项目的通病是因为他们的代码是基于fork官方webkit和其他内核的某个版本的trunk代码,所以跟不上一些最新的css属性和js语法,还有一些兼容性问题,不如真实的GUI浏览器发行版运行稳定。

其中,最成熟、用得最多的应该是PhantonJS。之前写过一篇关于这种爬虫识别的博客,这里不再赘述。PhantomJS 有很多问题,因为它是单进程模型,没有必要的沙箱保护,浏览器内核的安全性较差。此外,该项目的作者已经宣布他们将停止维护这个项目。

现在谷歌浏览器团队已经在 Chrome 59 发布版本中开放了 headless mode api,并开源了一个基于 Node.js 调用的 headless chromium dirver 库。我还为这个库贡献了一个centos环境部署依赖安装列表。

Headless Chrome 可以说是 Headless Browser 中独一无二的杀手锏。由于它本身就是一个 chrome 浏览器,它支持各种新的 CSS 渲染特性和 js 运行时语法。

基于这种方法,爬虫作为攻击方可以绕过几乎所有的服务器端验证逻辑,但是这些爬虫在客户端js运行时仍然存在一些缺陷,例如:

基于插件对象的检查

if(navigator.plugins.length === 0) {

console.log('It may be Chrome headless');

}

复制代码

基于语言的检查

if(navigator.languages === '') {

console.log('Chrome headless detected');

}

复制代码

基于 webgl 的检查

var canvas = document.createElement('canvas');

var gl = canvas.getContext('webgl');

var debugInfo = gl.getExtension('WEBGL_debug_renderer_info');

var vendor = gl.getParameter(debugInfo.UNMASKED_VENDOR_WEBGL);

var renderer = gl.getParameter(debugInfo.UNMASKED_RENDERER_WEBGL);

if(vendor == 'Brian Paul' && renderer == 'Mesa OffScreen') {

console.log('Chrome headless detected');

}

复制代码

基于浏览器细线属性的检查

if(!Modernizr['hairline']) {

console.log('It may be Chrome headless');

}

复制代码

检查基于错误的img src属性生成的img对象

var body = document.getElementsByTagName('body')[0];

var image = document.createElement('img');

image.src = 'http://iloveponeydotcom32188.jg';

image.setAttribute('id', 'fakeimage');

body.appendChild(image);

image.onerror = function(){

if(image.width == 0 && image.height == 0) {

console.log('Chrome headless detected');

}

}

复制代码

基于以上一些浏览器特性的判断,它基本上可以秒杀市面上大部分的Headless Browser程序。在这个层面上,网页爬虫的门槛其实是提高了,要求编写爬虫程序的开发者不得不修改浏览器内核的C++代码,重新编译一个浏览器,而以上特性对浏览器来说是很重要的。内核的改动其实不小,如果你尝试过编译Blink内核或者Gecko内核你就会明白对于一个“脚本小子”来说是多么的难了~

此外,我们还可以根据浏览器的UserAgent字段中描述的浏览器品牌、版本、型号信息,检查js运行时、DOM和BOM的各个native对象的属性和方法,观察特性是否符合浏览器这个版本。设备应具备的功能。

这种方法称为浏览器指纹识别技术,它依赖于大型网站对各类浏览器的api信息的采集。作为编写爬虫程序的攻击者,你可以在无头浏览器运行时预先注入一些js逻辑来伪造浏览器的特性。

另外,在研究Robots Browser Detect using js api在浏览器端的时候,我们发现了一个有趣的trick。可以将预先注入的js函数伪装成Native Function,看一下下面的代码:

var fakeAlert = (function(){}).bind(null);

console.log(window.alert.toString()); // function alert() { [native code] }

console.log(fakeAlert.toString()); // function () { [native code] }

复制代码

爬虫攻击者可能会预先注入一些js方法,用一层代理函数作为钩子包裹一些原生api,然后用这个假的js api覆盖原生api。如果防御者在函数 toString 之后基于对 [native code] 的检查来检查这一点,它将被绕过。所以需要更严格的检查,因为bind(null) fake方法在toString之后没有函数名,所以需要检查toString之后的函数名是否为空。

这个技巧有什么用?在这里延伸一下,反爬虫防御者有一个Robot Detect方法,就是在js运行的时候主动抛出一个alert。文案可以写一些业务逻辑相关的。当普通用户点击OK按钮时,肯定会有1s甚至是alert。对于更长的延迟,由于浏览器中的alert会阻塞js代码的运行(其实在v8中,他会以类似进程挂起的方式挂起isolate context的执行),所以爬虫作为攻击者可以选择使用上面的窍门,就是在页面所有js运行前预先注入一段js代码,伪造alert、prompt、confirm等所有弹窗方法。如果防御者在弹出代码之前检查他调用的alert方法是否仍然是原生的,则这种方式被阻止。

对付爬行动物的灵丹妙药

目前最可靠的反爬虫和机器人巡检手段是验证码技术。但是,验证码并不意味着必须强制用户输入一系列字母数字。还有很多基于用户鼠标、触摸屏(移动端)等行为的行为验证技术。其中,最成熟的是基于机器学习的谷歌reCAPTCHA。区分用户和爬虫。

基于以上对用户和爬虫的识别和区分技术,网站的防御者需要做的就是对该IP地址进行封锁或者对该IP的访问用户施加高强度的验证码策略。这样攻击者就不得不购买IP代理池来捕获网站信息内容,否则单个IP地址很容易被封杀,无法被捕获。爬取和反爬取的门槛已经提升到IP代理池的经济成本水平。

机器人协议

此外,在爬虫爬取技术领域,还有一种叫做robots协议的“白道”方式。您可以访问 网站 根目录中的 /robots.txt。比如我们看一下github的robot协议。Allow 和 Disallow 声明每个 UA 爬虫的授权。

然而,这只是君子之约。虽然它有法律上的好处,但它只能限制那些商业搜索引擎的蜘蛛程序,你不能限制那些“野爬爱好者”。

写在最后

网页内容的爬取与对抗,注定是一场魔高道高的猫捉老鼠游戏。你永远不可能用某种技术完全挡住爬虫的去路,你能做的就是增加攻击。用户爬取的成本,以及关于未经授权的爬取行为的更准确信息。

这篇文章中提到的验证码攻防其实是一个比较复杂的技术难点。我在这里留下一个悬念。有兴趣的可以多加关注,期待后续文章的详细阐述。

另外,欢迎对爬虫感兴趣的朋友关注我的开源项目webster。该项目以Node.js结合Chrome无头模式实现了一个高可用的网络爬虫爬取框架。一个页面中js和ajax渲染的所有异步内容;结合redis,实现了一个任务队列,让爬虫轻松进行横向和纵向分布式扩展。很容易部署,我已经为webster提供了一个正式版的base runtime docker镜像,如果你想先睹为快,你也可以试试这个webster demo docker image。

抓取网页生成电子书(如何用PowerBI的PowerQuery批量采集多个网页的数据(图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 195 次浏览 • 2022-04-19 01:39

前面介绍PowerBI数据获取的时候,我举了一个从网页获取数据的例子,但是当时只爬取了一页数据。本篇文章将介绍如何使用PowerBI的Power Query批处理采集Data为多个网页。Excel 中的操作类似。磷

本文以智联招聘网站为例,采集上海招聘信息。

以下是详细步骤:

(一)分析 URL 结构

打开智联招聘网站,搜索上海工作地点的资料,

将页面拉到最底部,找到显示页码的地方,点击前三页,网址如下,

%e4%b8%8a%e6%b5%b7&sm=0&sg=fe782ca83bfa4b018d27de559d0a5db0&p=1

%e4%b8%8a%e6%b5%b7&sm=0&sg=fe782ca83bfa4b018d27de559d0a5db0&p=2

%e4%b8%8a%e6%b5%b7&sm=0&sg=fe782ca83bfa4b018d27de559d0a5db0&p=3

可以看出,最后一个数字是页码的ID,是一个控制分页数据的变量。

(二)使用 PowerBI采集第一页的数据

打开PowerBI Desktop,从网页获取数据,在弹窗中选择【高级】,根据上面分析的URL结构,第一行输入除最后一页ID外的URL,第二行输入页码.

从 URL 预览可以看出,上面两行的 URL 已经自动合并在一起了;这里的单独输入只是为了以后更清楚地区分页码变量,其实直接输入完整的URL也是可以的。

(如果页码变量不是最后一位,而是在中间,则网址要分三行输入)

点击OK后,发现很多表,

从中可以看出智联招聘网站上的每个招聘信息都是一个表,不用管它,随便选一个表,比如勾选Table0,点击编辑进入Power Query编辑器。

在PQ编辑器中,直接删除[source]后面的所有步骤,然后展开数据,删除前面几列的数据。

这样第一页采集的数据就来了。然后整理这个页面的数据,删除无用的信息,添加字段名。可以看到,一页有60条招聘信息。

在这里完成第一页的数据后,当你转到采集的其他页面时,数据结构将与第一页完成后的数据结构相同,采集的数据可以直接使用;没关系,你可以等到采集所有网页数据都排序在一起。

如果要大量抓取网页数据,为了节省时间,可以不用对第一页的数据进行排序,直接进行下一步。

(三)根据页码参数设置自定义功能

这是最重要的一步。

还是刚才第一页数据的PQ编辑器窗口,打开【高级编辑器】,在let之前输入:

并且在let后面第一行的URL中,&后面的“1”变成了(这是第二步使用高级选项分两行输入URL的好处):

修改后 [source] 的 URL 变为:

确认后,刚才第一页数据的查询窗口变成了自定义函数的输入参数窗口,Table0表也变成了函数的样式。为了更直观,将此函数重命名为Data_Zhaopin。

至此,自定义功能完成。p是函数的变量,用来控制页码。如果输入数字,例如 7,将捕获第 7 页的数据。

输入参数一次只能抓取一个网页。批量爬取需要执行以下步骤。

(四)批量调用自定义函数

首先,使用一个空查询来创建一个数字序列。如果要获取前 100 页数据,请创建一个从 1 到 100 的序列并输入空查询。

回车生成一个从1到100的序列,然后变成表格。gif操作图如下:

然后调用自定义函数,

在弹出的窗口中,点击【函数查询】下拉框,选择刚刚创建的自定义函数Data_Zhaopin。

单击“确定”开始批量抓取网页。因为100页数据比较多,大概需要5分钟。这也是我提前进行第二步数据排序的结果,导致爬取慢。展开这张表,就是这100页的数据,

至此,已经完成了100页智联招聘信息的批量抓取。上面的步骤似乎很多。其实掌握之后,10分钟左右就可以搞定。最大的时间块仍然是最后一步。捕获数据的过程非常耗时。

网页上的数据不断更新。完成以上步骤后,在PQ中点击刷新,即可随时一键提取网站实时数据。做一次,受益终生!

以上主要使用了PowerBI中的Power Query功能,在能使用PQ功能的Excel中也可以进行同样的操作。

当然,PowerBI 不是专业的爬虫工具。如果网页比较复杂或者有反爬机制,还是得使用专业的工具,比如R或者Python。在使用PowerBI批量抓取某个网站数据之前,先尝试采集一个页面,如果可以采集获取,则使用上述步骤,如果采集不行当您到达时,您无需再浪费时间。

如果您是 Power BI 新手,可以前往微信公众号:“PowerBI 星球”,回复“PowerBI”,获取《PowerBI 七天入门》电子书,帮助您快速提高工作效率。 查看全部

抓取网页生成电子书(如何用PowerBI的PowerQuery批量采集多个网页的数据(图))

前面介绍PowerBI数据获取的时候,我举了一个从网页获取数据的例子,但是当时只爬取了一页数据。本篇文章将介绍如何使用PowerBI的Power Query批处理采集Data为多个网页。Excel 中的操作类似。磷

本文以智联招聘网站为例,采集上海招聘信息。

以下是详细步骤:

(一)分析 URL 结构

打开智联招聘网站,搜索上海工作地点的资料,

将页面拉到最底部,找到显示页码的地方,点击前三页,网址如下,

%e4%b8%8a%e6%b5%b7&sm=0&sg=fe782ca83bfa4b018d27de559d0a5db0&p=1

%e4%b8%8a%e6%b5%b7&sm=0&sg=fe782ca83bfa4b018d27de559d0a5db0&p=2

%e4%b8%8a%e6%b5%b7&sm=0&sg=fe782ca83bfa4b018d27de559d0a5db0&p=3

可以看出,最后一个数字是页码的ID,是一个控制分页数据的变量。

(二)使用 PowerBI采集第一页的数据

打开PowerBI Desktop,从网页获取数据,在弹窗中选择【高级】,根据上面分析的URL结构,第一行输入除最后一页ID外的URL,第二行输入页码.

从 URL 预览可以看出,上面两行的 URL 已经自动合并在一起了;这里的单独输入只是为了以后更清楚地区分页码变量,其实直接输入完整的URL也是可以的。

(如果页码变量不是最后一位,而是在中间,则网址要分三行输入)

点击OK后,发现很多表,

从中可以看出智联招聘网站上的每个招聘信息都是一个表,不用管它,随便选一个表,比如勾选Table0,点击编辑进入Power Query编辑器。

在PQ编辑器中,直接删除[source]后面的所有步骤,然后展开数据,删除前面几列的数据。

这样第一页采集的数据就来了。然后整理这个页面的数据,删除无用的信息,添加字段名。可以看到,一页有60条招聘信息。

在这里完成第一页的数据后,当你转到采集的其他页面时,数据结构将与第一页完成后的数据结构相同,采集的数据可以直接使用;没关系,你可以等到采集所有网页数据都排序在一起。

如果要大量抓取网页数据,为了节省时间,可以不用对第一页的数据进行排序,直接进行下一步。

(三)根据页码参数设置自定义功能

这是最重要的一步。

还是刚才第一页数据的PQ编辑器窗口,打开【高级编辑器】,在let之前输入:

并且在let后面第一行的URL中,&后面的“1”变成了(这是第二步使用高级选项分两行输入URL的好处):

修改后 [source] 的 URL 变为:

确认后,刚才第一页数据的查询窗口变成了自定义函数的输入参数窗口,Table0表也变成了函数的样式。为了更直观,将此函数重命名为Data_Zhaopin。

至此,自定义功能完成。p是函数的变量,用来控制页码。如果输入数字,例如 7,将捕获第 7 页的数据。

输入参数一次只能抓取一个网页。批量爬取需要执行以下步骤。

(四)批量调用自定义函数

首先,使用一个空查询来创建一个数字序列。如果要获取前 100 页数据,请创建一个从 1 到 100 的序列并输入空查询。

回车生成一个从1到100的序列,然后变成表格。gif操作图如下:

然后调用自定义函数,

在弹出的窗口中,点击【函数查询】下拉框,选择刚刚创建的自定义函数Data_Zhaopin。

单击“确定”开始批量抓取网页。因为100页数据比较多,大概需要5分钟。这也是我提前进行第二步数据排序的结果,导致爬取慢。展开这张表,就是这100页的数据,

至此,已经完成了100页智联招聘信息的批量抓取。上面的步骤似乎很多。其实掌握之后,10分钟左右就可以搞定。最大的时间块仍然是最后一步。捕获数据的过程非常耗时。

网页上的数据不断更新。完成以上步骤后,在PQ中点击刷新,即可随时一键提取网站实时数据。做一次,受益终生!

以上主要使用了PowerBI中的Power Query功能,在能使用PQ功能的Excel中也可以进行同样的操作。

当然,PowerBI 不是专业的爬虫工具。如果网页比较复杂或者有反爬机制,还是得使用专业的工具,比如R或者Python。在使用PowerBI批量抓取某个网站数据之前,先尝试采集一个页面,如果可以采集获取,则使用上述步骤,如果采集不行当您到达时,您无需再浪费时间。

如果您是 Power BI 新手,可以前往微信公众号:“PowerBI 星球”,回复“PowerBI”,获取《PowerBI 七天入门》电子书,帮助您快速提高工作效率。

抓取网页生成电子书(大牛与搬运工的差距——学习Python的正确姿势(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 111 次浏览 • 2022-04-19 01:38

阿里云 > 云栖社区 > 主题地图 > Z > 自己动手爬虫电子书

推荐活动:

更多优惠>

Current Topic: DIY Web Crawler 电子书加入采集

相关话题:

自己动手 网络爬虫 电子书 相关博客 查看更多博客

2018优秀译者评选,快来挑选你心中独一无二的人选吧,2018异步畅销新书都在这里

作者:异步社区 3713 浏览评论:03年前

人能通过一本书了解世界和时代吗?当然!任何优秀的作家都可以通过创新的学术研究,以文学作品展现自己的生命力和价值,成为读者窥视世界、了解事物的窗口。一个优秀的作家和他独特的艺术创作总是会被人津津乐道。当然,由于各种原因,一些优秀的

阅读全文

干货 | 学习Python的正确姿势

作者:gavin_hsueh4122 浏览评论:03年前

前段时间和大家分享了一篇关于学习方法的文章《丹尼尔和波特的差距——学习方法的力量》。我们将学习过程分为八个步骤,借鉴敏捷开发的迭代思想,达到自我迭代学习的效果。行动胜于雄辩,理论结合实践才是王道,所以在这篇文章中,我将在之前的学习方法的基础上,分享我是如何学习python的。

阅读全文

后端架构师技术图

作者:jackcooper20156238 浏览评论:03年前

数据结构队列集合链表、数组字典、关联数组堆栈树二叉树完全二叉树平衡二叉树二叉搜索树(BST)红黑树B-、B+、B*树LSM树BitSet常用算法排序、搜索算法选择冒泡排序 插入排序 快速排序 合并排序 希尔排序 堆排序

阅读全文

如何使用 Python 抓取数据?(一)网页抓取

作者:王淑仪2089 浏览评论:04年前

你期待已久的 Python 网络数据爬虫教程就在这里。本文向您展示了如何从网页中查找感兴趣的链接和描述,并在 Excel 中抓取和存储它们。我需要在公众号后台,经常可以收到读者的消息。许多评论是读者的问题。只要我有时间,我会尝试回答它。但是有些消息乍一看似乎不清楚

阅读全文

第一次了解 Scrapy,并在一个充满爬行动物的世界中成为一个好公民

作者:异步社区 2481 浏览评论:04年前

欢迎来到你的 Scrapy 之旅。通过这篇文章,我们的目标是让您从一个经验很少或没有经验的 Scrapy 初学者到有信心使用这个强大的框架从网络或其他来源抓取大型数据集的 Scrapy 专家。这篇文章将介绍 Scrapy 并向你展示一些你可以用它做的很酷的事情。1.1

阅读全文

阿里巴巴飞天大数据平台MaxCompute(原ODPS)完整指南(持续更新20200109)

作者:隐秘森林 123771 浏览评论:34年前

阿里巴巴飞天大数据平台MaxCompute不断演进;概述 大数据计算服务(MaxCompute,原名ODPS,产品地址:)是一种快速、全托管的TB/PB级数据仓库解决方案。麦克斯公司

阅读全文

网络爬虫 - 原理 (一)

作者:crazyacking1276 浏览评论:06年前

介绍:我们在百度首页输入关键词,点击百度,相关内容会立即显示。这个动作背后隐藏着哪些操作?事实上,百度的核心搜索引擎是一个大型分布式网络爬虫程序。什么是网络爬虫?详情请参考:1.百度百科2.维基百科网络爬虫的主要用途

阅读全文 查看全部

抓取网页生成电子书(大牛与搬运工的差距——学习Python的正确姿势(组图))

阿里云 > 云栖社区 > 主题地图 > Z > 自己动手爬虫电子书

推荐活动:

更多优惠>

Current Topic: DIY Web Crawler 电子书加入采集

相关话题:

自己动手 网络爬虫 电子书 相关博客 查看更多博客

2018优秀译者评选,快来挑选你心中独一无二的人选吧,2018异步畅销新书都在这里

作者:异步社区 3713 浏览评论:03年前

人能通过一本书了解世界和时代吗?当然!任何优秀的作家都可以通过创新的学术研究,以文学作品展现自己的生命力和价值,成为读者窥视世界、了解事物的窗口。一个优秀的作家和他独特的艺术创作总是会被人津津乐道。当然,由于各种原因,一些优秀的

阅读全文

干货 | 学习Python的正确姿势

作者:gavin_hsueh4122 浏览评论:03年前

前段时间和大家分享了一篇关于学习方法的文章《丹尼尔和波特的差距——学习方法的力量》。我们将学习过程分为八个步骤,借鉴敏捷开发的迭代思想,达到自我迭代学习的效果。行动胜于雄辩,理论结合实践才是王道,所以在这篇文章中,我将在之前的学习方法的基础上,分享我是如何学习python的。

阅读全文

后端架构师技术图

作者:jackcooper20156238 浏览评论:03年前

数据结构队列集合链表、数组字典、关联数组堆栈树二叉树完全二叉树平衡二叉树二叉搜索树(BST)红黑树B-、B+、B*树LSM树BitSet常用算法排序、搜索算法选择冒泡排序 插入排序 快速排序 合并排序 希尔排序 堆排序

阅读全文

如何使用 Python 抓取数据?(一)网页抓取

作者:王淑仪2089 浏览评论:04年前

你期待已久的 Python 网络数据爬虫教程就在这里。本文向您展示了如何从网页中查找感兴趣的链接和描述,并在 Excel 中抓取和存储它们。我需要在公众号后台,经常可以收到读者的消息。许多评论是读者的问题。只要我有时间,我会尝试回答它。但是有些消息乍一看似乎不清楚

阅读全文

第一次了解 Scrapy,并在一个充满爬行动物的世界中成为一个好公民

作者:异步社区 2481 浏览评论:04年前

欢迎来到你的 Scrapy 之旅。通过这篇文章,我们的目标是让您从一个经验很少或没有经验的 Scrapy 初学者到有信心使用这个强大的框架从网络或其他来源抓取大型数据集的 Scrapy 专家。这篇文章将介绍 Scrapy 并向你展示一些你可以用它做的很酷的事情。1.1

阅读全文

阿里巴巴飞天大数据平台MaxCompute(原ODPS)完整指南(持续更新20200109)

作者:隐秘森林 123771 浏览评论:34年前

阿里巴巴飞天大数据平台MaxCompute不断演进;概述 大数据计算服务(MaxCompute,原名ODPS,产品地址:)是一种快速、全托管的TB/PB级数据仓库解决方案。麦克斯公司

阅读全文

网络爬虫 - 原理 (一)

作者:crazyacking1276 浏览评论:06年前

介绍:我们在百度首页输入关键词,点击百度,相关内容会立即显示。这个动作背后隐藏着哪些操作?事实上,百度的核心搜索引擎是一个大型分布式网络爬虫程序。什么是网络爬虫?详情请参考:1.百度百科2.维基百科网络爬虫的主要用途

阅读全文

抓取网页生成电子书(如何将网页文章批量抓取、生成电子书、直接推送到Kindle)

网站优化 • 优采云 发表了文章 • 0 个评论 • 111 次浏览 • 2022-04-18 13:48

我一直在研究如何将我关心的网页或 文章 放入我的 Kindle 中进行认真阅读,但我已经很长时间没有取得任何真正的进展。手工排版制作电子书的方法虽然简单易行,但对于短小、更新频繁的网页文章来说效率低下。如果有一个工具可以文章批量抓取网页,生成电子书,然后直接推送到Kindle上就好了。Doocer 就是这样一种实用程序。

Doocer是@lepture开发的在线服务,允许用户在Pocket Read Later账户中提交URL、RSS提要地址和文章,然后逐一或批量制作成ePub和MOBI电子书. 您可以直接在 Doocer 中阅读所有文章,也可以将它们推送到 Kindle、Apple Books 中阅读。

真的很好的阅读体验

Doocer 生成的电子书在排版方面非常出色。应该有的内容很多,不应该有的内容不多。本书不仅封面图文并茂,还有文章目录、网站出处、文章原作者等信息。Doocer生成的MOBI电子书支持KF8标准,因此支持Kindle原生替换自定义字体。

由于网站文章通常有标准和通用的排版规范,Doocer生成的电子书文章中的大小标题和列表图例与原网页文章高度一致@>。原文章中的所有超链接也被保留,评论、广告等内容全部丢弃。整本书的阅读体验非常友好。(当然,如果原网页文章的布局没有规则,那么生成的电子书也可能面目全非。)

将网页 文章 制作成电子书

Doocer完成注册登录后,我们就可以开始将网页文章制作成电子书了。首先,我们点击“NEW BOOK”按钮新建电子书,输入电子书名称。接下来选择右上角的“添加”以添加 文章 URL 或 RSS 提要地址。

以小众网页的文章为例,我们选择“FEED”,在输入框中粘贴RSS地址,然后点击“PARSE”,那么小众最近的文章列表就会出现为我们显示添加到。我们可以根据需要选择,也可以点击“SELECT ALL”全选文章。最后,下拉到页面底部,选择“SAVE”,那么这些文章就会被添加到书里。

其实Doocer网页与RSS工具很相似,实现了从网站批量抓取文章并集中展示的功能。

要将这些 文章 转换为电子书并将它们推送到 Kindle,我们必须做一些简单的事情。

首先,根据Doocer个人设置页面的提示,打开Amazon Kindle的个人文档设置,将Doocer电子书的发送地址添加到个人文档接收地址中。完成后,我们在输入框中填写Kindle的个人文档接收地址,点击保存。

最后,我们在 Doocer 中打开《少数派》这本书,在页面上找到“Publish”,选择 Send to Kindle。大约 10 到 30 分钟,Doocer 将完成图书制作并将图书推送到 Kindle。

仍有一些问题需要注意

Doocer目前处于beta测试阶段,还有一些bug,尤其是中文网站经常出现问题。好在Doocer官网有开发者对话频道,可以直接联系他帮忙解决。

自动化所有操作的过程是我认为 Doocer 最需要做的事情。Doocer可以像RSS工具一样抓取网页中更新的文章,但是要抓取新的文章并生成电子书并推送,仍然需要手动完成。如果整个过程可以自动化,RSS - MOBI - Kindle 一口气,相信它的用处会更好。

目前,Doocer 的所有功能都可以免费使用。 查看全部

抓取网页生成电子书(如何将网页文章批量抓取、生成电子书、直接推送到Kindle)

我一直在研究如何将我关心的网页或 文章 放入我的 Kindle 中进行认真阅读,但我已经很长时间没有取得任何真正的进展。手工排版制作电子书的方法虽然简单易行,但对于短小、更新频繁的网页文章来说效率低下。如果有一个工具可以文章批量抓取网页,生成电子书,然后直接推送到Kindle上就好了。Doocer 就是这样一种实用程序。

Doocer是@lepture开发的在线服务,允许用户在Pocket Read Later账户中提交URL、RSS提要地址和文章,然后逐一或批量制作成ePub和MOBI电子书. 您可以直接在 Doocer 中阅读所有文章,也可以将它们推送到 Kindle、Apple Books 中阅读。

真的很好的阅读体验

Doocer 生成的电子书在排版方面非常出色。应该有的内容很多,不应该有的内容不多。本书不仅封面图文并茂,还有文章目录、网站出处、文章原作者等信息。Doocer生成的MOBI电子书支持KF8标准,因此支持Kindle原生替换自定义字体。

由于网站文章通常有标准和通用的排版规范,Doocer生成的电子书文章中的大小标题和列表图例与原网页文章高度一致@>。原文章中的所有超链接也被保留,评论、广告等内容全部丢弃。整本书的阅读体验非常友好。(当然,如果原网页文章的布局没有规则,那么生成的电子书也可能面目全非。)

将网页 文章 制作成电子书

Doocer完成注册登录后,我们就可以开始将网页文章制作成电子书了。首先,我们点击“NEW BOOK”按钮新建电子书,输入电子书名称。接下来选择右上角的“添加”以添加 文章 URL 或 RSS 提要地址。

以小众网页的文章为例,我们选择“FEED”,在输入框中粘贴RSS地址,然后点击“PARSE”,那么小众最近的文章列表就会出现为我们显示添加到。我们可以根据需要选择,也可以点击“SELECT ALL”全选文章。最后,下拉到页面底部,选择“SAVE”,那么这些文章就会被添加到书里。

其实Doocer网页与RSS工具很相似,实现了从网站批量抓取文章并集中展示的功能。

要将这些 文章 转换为电子书并将它们推送到 Kindle,我们必须做一些简单的事情。

首先,根据Doocer个人设置页面的提示,打开Amazon Kindle的个人文档设置,将Doocer电子书的发送地址添加到个人文档接收地址中。完成后,我们在输入框中填写Kindle的个人文档接收地址,点击保存。

最后,我们在 Doocer 中打开《少数派》这本书,在页面上找到“Publish”,选择 Send to Kindle。大约 10 到 30 分钟,Doocer 将完成图书制作并将图书推送到 Kindle。

仍有一些问题需要注意

Doocer目前处于beta测试阶段,还有一些bug,尤其是中文网站经常出现问题。好在Doocer官网有开发者对话频道,可以直接联系他帮忙解决。

自动化所有操作的过程是我认为 Doocer 最需要做的事情。Doocer可以像RSS工具一样抓取网页中更新的文章,但是要抓取新的文章并生成电子书并推送,仍然需要手动完成。如果整个过程可以自动化,RSS - MOBI - Kindle 一口气,相信它的用处会更好。

目前,Doocer 的所有功能都可以免费使用。

抓取网页生成电子书(《后期制作》自动重试怎么做?怎么提取? )

网站优化 • 优采云 发表了文章 • 0 个评论 • 106 次浏览 • 2022-04-17 21:34

)

主要功能:可以提取和调整指定小说目录页的章节信息,然后按照章节顺序抓取小说内容,然后合并在一起。爬取过程可以随时中断,关闭程序后可以恢复上一个任务。

特色功能1、章节调整:提取目录后,可以进行移动、删除、反转等调整操作。调整将直接影响调整后的章节顺序中的最终书籍和输出。

2、自动重试:爬取过程中,可能由于网络因素导致爬取失败。本程序可能会自动重试直到成功,或者暂时中断爬取(中断后关闭程序不会影响进度),等网络好了再试。

3、停止和恢复:可以随时停止捕捉过程,退出程序后不影响进度(章节信息会保存在记录中,程序结束后可以恢复捕捉下次运行。注意:需要先用停止键中断,然后退出程序,如果直接退出,将无法恢复)。

4、一键抓取:又称“傻瓜模式”,基本可以实现全自动抓取合并功能,直接输出最终的文本文件。前面可能需要输入最基本的URL、save bit等信息(会有明显的操作提示),调整章节后也可以使用一键爬取,爬取和合并操作会自动完成。

5、适用网站:已输入10个适用网站(选择后可快速打开网站找到想要的书),以及相应的代码也可以自动应用,其他小说网站也可以测试,如果一起使用,可以手动添加到设置文件中备份。

6、轻松制作电子书:可以在设置文件中添加每章名称的前缀和后缀,为后期制作电子书的编目带来极大的方便。

查看全部

抓取网页生成电子书(《后期制作》自动重试怎么做?怎么提取?

)

主要功能:可以提取和调整指定小说目录页的章节信息,然后按照章节顺序抓取小说内容,然后合并在一起。爬取过程可以随时中断,关闭程序后可以恢复上一个任务。

特色功能1、章节调整:提取目录后,可以进行移动、删除、反转等调整操作。调整将直接影响调整后的章节顺序中的最终书籍和输出。

2、自动重试:爬取过程中,可能由于网络因素导致爬取失败。本程序可能会自动重试直到成功,或者暂时中断爬取(中断后关闭程序不会影响进度),等网络好了再试。

3、停止和恢复:可以随时停止捕捉过程,退出程序后不影响进度(章节信息会保存在记录中,程序结束后可以恢复捕捉下次运行。注意:需要先用停止键中断,然后退出程序,如果直接退出,将无法恢复)。

4、一键抓取:又称“傻瓜模式”,基本可以实现全自动抓取合并功能,直接输出最终的文本文件。前面可能需要输入最基本的URL、save bit等信息(会有明显的操作提示),调整章节后也可以使用一键爬取,爬取和合并操作会自动完成。

5、适用网站:已输入10个适用网站(选择后可快速打开网站找到想要的书),以及相应的代码也可以自动应用,其他小说网站也可以测试,如果一起使用,可以手动添加到设置文件中备份。

6、轻松制作电子书:可以在设置文件中添加每章名称的前缀和后缀,为后期制作电子书的编目带来极大的方便。

抓取网页生成电子书(PostedJanuary14,安装Bash官网文档提供的安装脚本看似简单)

网站优化 • 优采云 发表了文章 • 0 个评论 • 114 次浏览 • 2022-04-17 15:00

Scrapy 抓取热门短书生成电子书发送到 Kindle 发表于 2016 年 1 月 14 日

简书是个很好的学习者网站,我大多只关注首页的人文章,但是最近因为忙,错过了很多首页的文章,所以我有个想法,把每日热门Top生成mobi并推送到kindle。这样一来,在地铁上就能很快搞定。

环境准备:

关于口径安装

重击

sudo -v && wget -nv -O- https://raw.githubusercontent. ... er.py | sudo python -c "import sys; main=lambda:sys.stderr.write('Download failed\n'); exec(sys.stdin.read()); main()"

官网文档提供的安装脚本看似简单,执行后即可安装使用,但调用ebook-convert时gitbook会报错。这里报的错误应该是QT错误(至少我遇到过,具体错误信息忘记截图了)如果遇到这个错误,直接安装QT pyQT即可。calibre安装页面有依赖表

安装 Gitbook

需要安装 nodejs 和 npm 然后执行 npm install -g gitbook-cli

安装建树热

需要强调的是,这部分需要解决很多依赖,

scrapy依赖的python包有很多,这些依赖的python大部分都需要一些系统库。如有需要,需要安装apt-get和yum,如python-devel libffi-devel libxml-devel等...

peewee(数据库ORM)需要mysql-devel,上面的例子都知道,这个是我部署后写的,部署过程就不详细记录了,现在只能凭记忆写这一章了。

重击

$ git clone https://github.com/jackeyGao/jianshuHot

$ cd jianshuHot

$ pip install -r requirements.txt

初始化器

重击

$ sh init.sh

邮件配置

这是用于发送电子邮件的 sendEmail 和下载地址。解压后将解压后的sendEmail重命名为/usr/local/bin/sendEmail。理论上可以安装成功。这是免编译的,只需要在机器上安装 perl。

然后修改start.sh邮箱配置,写成自己的163邮箱,也可以用其他品牌邮箱,如果用其他品牌别忘了改,改到对应的smtp服务器就好了。

注意:无论您使用哪个电子邮件地址,您都必须将此电子邮件帐户添加到亚马逊的批准发件人电子邮件列表中,以确保您发送的文件可以到达亚马逊云

重击

$ vim start.sh

....

YOURKINDLE_MAIL_ADDRESS="[email protected]"

YOUR_SEND_MAIL_USERNAME="[email protected]"

YOUR_SEND_MAIL_SECRET = 'xxxxxxxxxxxx'

MOBI_BOOK_PATH='./output/book.mobi'

...

开始爬行

重击

$ sh start.sh

执行后会自动抓取页面生成markdown,下载每个文章的图片,然后gitbook会通过markdown生成这个文档列表的book.mobi(output/book.mobi),并在start.sh 的末尾有一个备份操作会将这个 mobi 备份到 output/books。然后发送到指定kindle地址邮箱。 查看全部

抓取网页生成电子书(PostedJanuary14,安装Bash官网文档提供的安装脚本看似简单)

Scrapy 抓取热门短书生成电子书发送到 Kindle 发表于 2016 年 1 月 14 日

简书是个很好的学习者网站,我大多只关注首页的人文章,但是最近因为忙,错过了很多首页的文章,所以我有个想法,把每日热门Top生成mobi并推送到kindle。这样一来,在地铁上就能很快搞定。

环境准备:

关于口径安装

重击

sudo -v && wget -nv -O- https://raw.githubusercontent. ... er.py | sudo python -c "import sys; main=lambda:sys.stderr.write('Download failed\n'); exec(sys.stdin.read()); main()"

官网文档提供的安装脚本看似简单,执行后即可安装使用,但调用ebook-convert时gitbook会报错。这里报的错误应该是QT错误(至少我遇到过,具体错误信息忘记截图了)如果遇到这个错误,直接安装QT pyQT即可。calibre安装页面有依赖表

安装 Gitbook

需要安装 nodejs 和 npm 然后执行 npm install -g gitbook-cli

安装建树热

需要强调的是,这部分需要解决很多依赖,

scrapy依赖的python包有很多,这些依赖的python大部分都需要一些系统库。如有需要,需要安装apt-get和yum,如python-devel libffi-devel libxml-devel等...

peewee(数据库ORM)需要mysql-devel,上面的例子都知道,这个是我部署后写的,部署过程就不详细记录了,现在只能凭记忆写这一章了。

重击

$ git clone https://github.com/jackeyGao/jianshuHot

$ cd jianshuHot

$ pip install -r requirements.txt

初始化器

重击

$ sh init.sh

邮件配置

这是用于发送电子邮件的 sendEmail 和下载地址。解压后将解压后的sendEmail重命名为/usr/local/bin/sendEmail。理论上可以安装成功。这是免编译的,只需要在机器上安装 perl。

然后修改start.sh邮箱配置,写成自己的163邮箱,也可以用其他品牌邮箱,如果用其他品牌别忘了改,改到对应的smtp服务器就好了。

注意:无论您使用哪个电子邮件地址,您都必须将此电子邮件帐户添加到亚马逊的批准发件人电子邮件列表中,以确保您发送的文件可以到达亚马逊云

重击

$ vim start.sh

....

YOURKINDLE_MAIL_ADDRESS="[email protected]"

YOUR_SEND_MAIL_USERNAME="[email protected]"

YOUR_SEND_MAIL_SECRET = 'xxxxxxxxxxxx'

MOBI_BOOK_PATH='./output/book.mobi'

...

开始爬行

重击

$ sh start.sh

执行后会自动抓取页面生成markdown,下载每个文章的图片,然后gitbook会通过markdown生成这个文档列表的book.mobi(output/book.mobi),并在start.sh 的末尾有一个备份操作会将这个 mobi 备份到 output/books。然后发送到指定kindle地址邮箱。

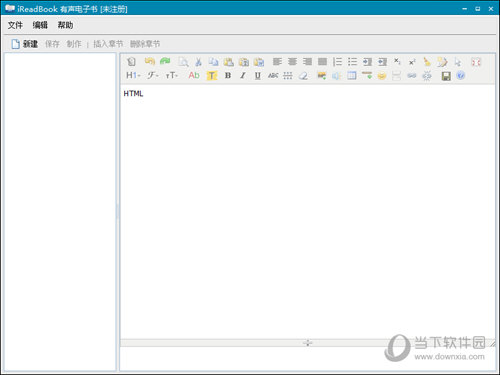

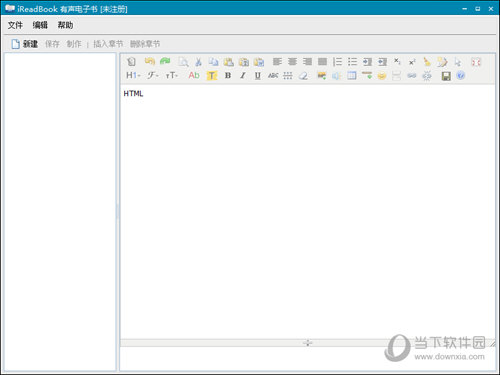

抓取网页生成电子书(ireadbook使用KindEditor编辑器以所见所得)

网站优化 • 优采云 发表了文章 • 0 个评论 • 138 次浏览 • 2022-04-17 10:34

ireadbook reader是一款简单实用的电子书制作软件。可以帮助用户快速制作出高质量的有声电子书,软件界面简洁、小巧、好用,有需要的用户不要错过。

【软件特色】

1. 快速添加章节并编辑标题以显示在目录树中。

2. 使用 KindEditor 编辑器以所见即所得的方式编辑页面内容,包括修改字体大小和格式。

3. 可以插入jpg/gif/png等多种格式的图片。

4. 支持mp3/wma等音频格式,阅读器提供内置播放器。

5. 免费使用,绿色软件,无需安装。

【使用说明】

1.txt文本格式:ansi,utf-8、unicode格式自动识别;

2.网页内容:与网页浏览器集成,可以直接从浏览的网页中抓取文字内容,放入新的章节;

3. 字格式;

智能拆分章节,自定义拆分规则,可以根据设定的规则拆分大源文件。

按固定长度拆分章节,拆分的章节保持段落完整。

支持插入图片。epub 支持的图片格式有 gif、jpg、jpeg 和 bmp。

支持章节顺序调整。

多种输出格式:epub、内嵌字体的epub格式(可在sony阅读器上浏览)、txt格式(分章节)、html格式(utf-8编码)、pdf格式;

上传epub书籍到iphone、ipod touch,上传的书籍可以直接用stanza打开(带缩略图、封面、书籍介绍)

注意:需要在 iPhone 和 iPod touch 上安装 OPEN SSH。

修复了合并章节软件崩溃的BUG;修复生成的epub在部分阅读器上有重叠段落的问题 查看全部

抓取网页生成电子书(ireadbook使用KindEditor编辑器以所见所得)

ireadbook reader是一款简单实用的电子书制作软件。可以帮助用户快速制作出高质量的有声电子书,软件界面简洁、小巧、好用,有需要的用户不要错过。

【软件特色】

1. 快速添加章节并编辑标题以显示在目录树中。

2. 使用 KindEditor 编辑器以所见即所得的方式编辑页面内容,包括修改字体大小和格式。

3. 可以插入jpg/gif/png等多种格式的图片。

4. 支持mp3/wma等音频格式,阅读器提供内置播放器。

5. 免费使用,绿色软件,无需安装。

【使用说明】

1.txt文本格式:ansi,utf-8、unicode格式自动识别;

2.网页内容:与网页浏览器集成,可以直接从浏览的网页中抓取文字内容,放入新的章节;

3. 字格式;

智能拆分章节,自定义拆分规则,可以根据设定的规则拆分大源文件。

按固定长度拆分章节,拆分的章节保持段落完整。

支持插入图片。epub 支持的图片格式有 gif、jpg、jpeg 和 bmp。

支持章节顺序调整。

多种输出格式:epub、内嵌字体的epub格式(可在sony阅读器上浏览)、txt格式(分章节)、html格式(utf-8编码)、pdf格式;

上传epub书籍到iphone、ipod touch,上传的书籍可以直接用stanza打开(带缩略图、封面、书籍介绍)

注意:需要在 iPhone 和 iPod touch 上安装 OPEN SSH。

修复了合并章节软件崩溃的BUG;修复生成的epub在部分阅读器上有重叠段落的问题

抓取网页生成电子书(网页设计师有时使用屏幕抓取的另一个常见用法是什么)

网站优化 • 优采云 发表了文章 • 0 个评论 • 95 次浏览 • 2022-04-17 10:32

屏幕抓取是计算机显示器上显示的任何内容的静止图像。这些图像有很多用途,从产品推广到软件故障排除,大多数计算机都能够快速生成屏幕抓取,让用户更轻松地使用它们

大多数操作系统允许用户通过按下命令键和键盘上的一两个其他键来抓取屏幕。抓取时,计算机会捕获当时显示器上显示的图像,并保留所有可见的细节。生成的图像通常与显示器大小相同;如果需要,用户可以减小图像的大小以使其更易于使用。屏幕抓取最常见的用途之一是用于软件的宣传材料。例如,许多电脑游戏使用屏幕抓取来做广告,展示游戏的图像质量和显示效果,以试图让用户对外观感兴趣。您还可以看到其他类型软件的广告抓取,显示软件的功能和外观。许多公司还在其用户手册中使用这些图片来直观地向用户展示如何做事。屏幕抓取的另一个常见用途是故障排除。当用户遇到程序错误或问题时,他或她可以截屏来说明情况。人们有时还使用屏幕截图来记录其他内容,例如他们完成任务所采取的步骤。人们使用幽默的抓图来说明他们周围的有趣情况或事件也并不少见。这些图像还有许多其他用途。例如,博主有时会在链接到其他 网站 时使用屏幕抓取来吸引人们加入有趣的视觉内容。人们也可能会抓取抄袭或被盗的内容,因此即使内容后来被删除,他们也有证据。网页设计师有时也使用这种方法来记录网络上视觉上有趣或有趣的网页,以供以后参考 查看全部

抓取网页生成电子书(网页设计师有时使用屏幕抓取的另一个常见用法是什么)

屏幕抓取是计算机显示器上显示的任何内容的静止图像。这些图像有很多用途,从产品推广到软件故障排除,大多数计算机都能够快速生成屏幕抓取,让用户更轻松地使用它们

大多数操作系统允许用户通过按下命令键和键盘上的一两个其他键来抓取屏幕。抓取时,计算机会捕获当时显示器上显示的图像,并保留所有可见的细节。生成的图像通常与显示器大小相同;如果需要,用户可以减小图像的大小以使其更易于使用。屏幕抓取最常见的用途之一是用于软件的宣传材料。例如,许多电脑游戏使用屏幕抓取来做广告,展示游戏的图像质量和显示效果,以试图让用户对外观感兴趣。您还可以看到其他类型软件的广告抓取,显示软件的功能和外观。许多公司还在其用户手册中使用这些图片来直观地向用户展示如何做事。屏幕抓取的另一个常见用途是故障排除。当用户遇到程序错误或问题时,他或她可以截屏来说明情况。人们有时还使用屏幕截图来记录其他内容,例如他们完成任务所采取的步骤。人们使用幽默的抓图来说明他们周围的有趣情况或事件也并不少见。这些图像还有许多其他用途。例如,博主有时会在链接到其他 网站 时使用屏幕抓取来吸引人们加入有趣的视觉内容。人们也可能会抓取抄袭或被盗的内容,因此即使内容后来被删除,他们也有证据。网页设计师有时也使用这种方法来记录网络上视觉上有趣或有趣的网页,以供以后参考

抓取网页生成电子书(大数据技术前几年成就了很多科技公司的爬虫技术)

网站优化 • 优采云 发表了文章 • 0 个评论 • 94 次浏览 • 2022-04-14 18:31

开幕

大数据技术这几年成就了很多科技公司。至于成就有多大,很难说爬虫技术火了。因为很多大数据公司都有爬虫爬取、清洗、分析、销售的数据。比如很多网络舆情系统、网络热点监控系统等等。我工作的公司以前负责过这样的项目。当然,这些系统的核心是爬虫技术。今天,我将调试这样一个项目。需要开源项目地址的同学,请移到文章的末尾,有开源作者的链接。

履带技术介绍

什么是爬行动物?实际上,网络爬虫是一种自动提取网页的程序。它被搜索引擎、大数据公司和许多灰色地带使用,例如寻找漏洞的黑客。爬虫从一个或多个初始网页的URL开始,获取初始网页上的URL。在抓取网页的过程中,它不断地从当前页面中提取新的 URL 并放入队列中,直到满足系统的某些停止条件。对于大数据公司来说,通过爬取互联网上的公开数据可以获得一些有价值的结果,可供决策者使用。当然,过程中得到的分析结果也可以对后续的爬取过程给予反馈和指导。

我曾经为我现在的公司抓取了一个 8 年的公共数据的天气网站,用于分析农业天气数据,例如什么时候种什么,什么时候不种。当然,今天的话题不是这些,它是一个开源项目。

技术是好是坏

现在很多网站都有反爬虫技术了,当然很多爬虫技术也在迭代升级。我们不会在本文中讨论爬虫技术的质量。我认为技术没有好坏之分,只有使用技术的人才有好有坏。爬虫技术是很多企业的核心技术,也是攻城狮要学习的技术。

核心调试

1、Forever IDEA从开源地址导入

导入后是这样的

2、介绍爬虫sql,当然这个爬虫项目有很多插件可用,我这里只调试最小可运行单元。有兴趣的可以自己调试。插件包括 selenium、redis、mongodb、oss、ocr 和 IP 代理池插件。

3、运行项目,这个项目的开源主页有详细介绍,这里我只运行看看效果,系统图自带两个例子。

结语

这个开源项目是gitee的GVP项目,是学习爬虫的一个很好的例子。当然,如果不懂技术的同学可以自己学用,不用看代码也可以用。但如果你了解这项技术,你最好看看。毕竟爬虫的技术还是比较好学的。许多公司依靠它来发财。感谢开源作者,开源让世界变得更美好。如果觉得有用,请采集、转发、关注。如需爬虫项目地址,请私信“爬虫”,我发给你作者的开源地址。

我还调试了很多其他的开源项目,如果你觉得有用,就看看吧:

花了三个小时调试了近50个常用小工具开源项目的合集

Java Springboot开源微服务架构管理后台搭建实战

京东SSO调试开源单点登录项目实战

Java史上集成最全的第三方登录开源项目的调试实践

Java分布式架构开源支付项目调试

Java 100%开源基于Spring boot的ERP系统调试实践

开源OA项目调试实践 查看全部

抓取网页生成电子书(大数据技术前几年成就了很多科技公司的爬虫技术)

开幕

大数据技术这几年成就了很多科技公司。至于成就有多大,很难说爬虫技术火了。因为很多大数据公司都有爬虫爬取、清洗、分析、销售的数据。比如很多网络舆情系统、网络热点监控系统等等。我工作的公司以前负责过这样的项目。当然,这些系统的核心是爬虫技术。今天,我将调试这样一个项目。需要开源项目地址的同学,请移到文章的末尾,有开源作者的链接。

履带技术介绍

什么是爬行动物?实际上,网络爬虫是一种自动提取网页的程序。它被搜索引擎、大数据公司和许多灰色地带使用,例如寻找漏洞的黑客。爬虫从一个或多个初始网页的URL开始,获取初始网页上的URL。在抓取网页的过程中,它不断地从当前页面中提取新的 URL 并放入队列中,直到满足系统的某些停止条件。对于大数据公司来说,通过爬取互联网上的公开数据可以获得一些有价值的结果,可供决策者使用。当然,过程中得到的分析结果也可以对后续的爬取过程给予反馈和指导。

我曾经为我现在的公司抓取了一个 8 年的公共数据的天气网站,用于分析农业天气数据,例如什么时候种什么,什么时候不种。当然,今天的话题不是这些,它是一个开源项目。

技术是好是坏

现在很多网站都有反爬虫技术了,当然很多爬虫技术也在迭代升级。我们不会在本文中讨论爬虫技术的质量。我认为技术没有好坏之分,只有使用技术的人才有好有坏。爬虫技术是很多企业的核心技术,也是攻城狮要学习的技术。

核心调试

1、Forever IDEA从开源地址导入

导入后是这样的

2、介绍爬虫sql,当然这个爬虫项目有很多插件可用,我这里只调试最小可运行单元。有兴趣的可以自己调试。插件包括 selenium、redis、mongodb、oss、ocr 和 IP 代理池插件。

3、运行项目,这个项目的开源主页有详细介绍,这里我只运行看看效果,系统图自带两个例子。

结语

这个开源项目是gitee的GVP项目,是学习爬虫的一个很好的例子。当然,如果不懂技术的同学可以自己学用,不用看代码也可以用。但如果你了解这项技术,你最好看看。毕竟爬虫的技术还是比较好学的。许多公司依靠它来发财。感谢开源作者,开源让世界变得更美好。如果觉得有用,请采集、转发、关注。如需爬虫项目地址,请私信“爬虫”,我发给你作者的开源地址。

我还调试了很多其他的开源项目,如果你觉得有用,就看看吧:

花了三个小时调试了近50个常用小工具开源项目的合集

Java Springboot开源微服务架构管理后台搭建实战

京东SSO调试开源单点登录项目实战

Java史上集成最全的第三方登录开源项目的调试实践

Java分布式架构开源支付项目调试

Java 100%开源基于Spring boot的ERP系统调试实践

开源OA项目调试实践

抓取网页生成电子书(用Sigil加Calibre,支持Windows,Mac,Linux(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 121 次浏览 • 2022-04-14 04:20

因为看惯了kindle pw,在电脑屏幕上看一大段文章很难专心,感觉很累。

能够为kpw带来好的文章、博客、文档、自组织材料等,真是太高兴了。可以说,制作电子书已经成为刚需,所以谷歌告诉我用Sigil加Calibre,就是用Sigil做一个标准的ePub格式,然后用Calibre转换成你想要的任何格式。

这里是 Sigil,它托管在 Google 代码上,但源代码现在在 github 上,支持 Windows、Mac、Linux。用户指南非常详细。

这是界面,支持多种语言:

图一

不好意思说最近才学git,所以找到了这个ProGit。可惜官方只有epub格式的英文版下载。看了之后,中文只有网页版,所以想自己做一个。以下是如何执行此操作的示例。

ePub格式归根结底就是一个zip格式的压缩包,里面定义了每个文件夹,里面收录了文字、图片等各种素材,如图2

图2

在Text下右击“Add Blank HTML File”,会自动创建一个名为Seciton0001.xhtml的空白文件。然后只需复制您想要的内容,它可以是纯文本或网络格式。见图3

图 3

它实际上是所见即所得(所见即所得),您可以查看它的各种元素。见图4

图 4

然后将要放到每个xhtml文件上的内容一个一个地放上去,可以在格式菜单中进行粗体、斜体等修改。

需要注意的是标题h1、h2、h3等(图4)是用来定义书的章节的,从小到大是收录关系,p定义段落,定义好每一页的标题后,我们就可以为我们的书创建一个目录了,菜单工具->目录->生成目录(如图5),确定目录级别通过level选项来收录,然后OK,会自动生成目录(如图6).

图 4

图 5

图 6

接下来,添加封面,不然会尴尬:菜单工具->生成封面,将准备好的图片添加到素材中。

图 7

最后我们来润色一下书,菜单Tools -> Element Data Editor,添加title、author等参数。

图 8

至此,一本书所需的基本东西都已经完成,保存完毕,并自动生成了一个标准的epub格式文件。

有了它,添加到calibre后,选择把书转换成你需要的任何格式。

图 9

完成。 查看全部

抓取网页生成电子书(用Sigil加Calibre,支持Windows,Mac,Linux(组图))

因为看惯了kindle pw,在电脑屏幕上看一大段文章很难专心,感觉很累。

能够为kpw带来好的文章、博客、文档、自组织材料等,真是太高兴了。可以说,制作电子书已经成为刚需,所以谷歌告诉我用Sigil加Calibre,就是用Sigil做一个标准的ePub格式,然后用Calibre转换成你想要的任何格式。

这里是 Sigil,它托管在 Google 代码上,但源代码现在在 github 上,支持 Windows、Mac、Linux。用户指南非常详细。

这是界面,支持多种语言:

图一

不好意思说最近才学git,所以找到了这个ProGit。可惜官方只有epub格式的英文版下载。看了之后,中文只有网页版,所以想自己做一个。以下是如何执行此操作的示例。

ePub格式归根结底就是一个zip格式的压缩包,里面定义了每个文件夹,里面收录了文字、图片等各种素材,如图2

图2

在Text下右击“Add Blank HTML File”,会自动创建一个名为Seciton0001.xhtml的空白文件。然后只需复制您想要的内容,它可以是纯文本或网络格式。见图3

图 3

它实际上是所见即所得(所见即所得),您可以查看它的各种元素。见图4

图 4

然后将要放到每个xhtml文件上的内容一个一个地放上去,可以在格式菜单中进行粗体、斜体等修改。

需要注意的是标题h1、h2、h3等(图4)是用来定义书的章节的,从小到大是收录关系,p定义段落,定义好每一页的标题后,我们就可以为我们的书创建一个目录了,菜单工具->目录->生成目录(如图5),确定目录级别通过level选项来收录,然后OK,会自动生成目录(如图6).

图 4

图 5

图 6

接下来,添加封面,不然会尴尬:菜单工具->生成封面,将准备好的图片添加到素材中。

图 7

最后我们来润色一下书,菜单Tools -> Element Data Editor,添加title、author等参数。

图 8

至此,一本书所需的基本东西都已经完成,保存完毕,并自动生成了一个标准的epub格式文件。

有了它,添加到calibre后,选择把书转换成你需要的任何格式。

图 9

完成。

抓取网页生成电子书(易天下科技:网站建设需要注意的几个注意事项)

网站优化 • 优采云 发表了文章 • 0 个评论 • 92 次浏览 • 2022-04-12 02:36

亿天下科技位于美丽的苏州,专业从事网站建设。SEO经过多年的优化,已经形成了自己的一套方法。今天就来说说网站的构建需要注意的几点:

一、显式网站主题

我们通常做任何事情都有一定的目的。网站我们在建造时也是如此。网站在建设初期,要分析竞争对手,差异化内容定位,确定我们的目标人群,确定,后期网站建设会围绕这个进行。

网站构建的时候一定要注重自己的强项,网站定位内容也应该是自己的专长。抓住这一点聚合网站资源是网站成功的关键。

二、url 的唯一性

我们要保证网站的每一页的唯一性,即一页对应一个url,同时设置网站301来判断页面url的唯一性,准备好网站链接的设置可以保证每个页面的权重集中而不分散,从而提高网站的排名。

三、目录结构规范化

网站目录结构的规范化可以提高爬虫的爬取效率,层级不宜过深以提高页面的爬取概率。

四、内链构建

从一个新的 网站 开始并不多。从构建前期就必须做好,比如内容页的上一页和下一页,侧边栏的相关调用等等,都必须在内循环的构建中完成,合理的内链结构可以大大缩短。页面的收录时间,所以需要了解网站生态内部链规则。

五、网站地图

网站如果地图配置了很多后台程序自然生成的地图,就可以了。这是非常简单和必要的。

六、404 页

404页面我想大部分站长朋友都知道它的用途。站点中不存在或将不存在的所有页面都应指向该页面。404页面的设置是搜索引擎友好的一种形式。, 所以 网站 必须在开始构建时考虑在内。 查看全部

抓取网页生成电子书(易天下科技:网站建设需要注意的几个注意事项)

亿天下科技位于美丽的苏州,专业从事网站建设。SEO经过多年的优化,已经形成了自己的一套方法。今天就来说说网站的构建需要注意的几点:

一、显式网站主题

我们通常做任何事情都有一定的目的。网站我们在建造时也是如此。网站在建设初期,要分析竞争对手,差异化内容定位,确定我们的目标人群,确定,后期网站建设会围绕这个进行。

网站构建的时候一定要注重自己的强项,网站定位内容也应该是自己的专长。抓住这一点聚合网站资源是网站成功的关键。

二、url 的唯一性

我们要保证网站的每一页的唯一性,即一页对应一个url,同时设置网站301来判断页面url的唯一性,准备好网站链接的设置可以保证每个页面的权重集中而不分散,从而提高网站的排名。

三、目录结构规范化

网站目录结构的规范化可以提高爬虫的爬取效率,层级不宜过深以提高页面的爬取概率。

四、内链构建

从一个新的 网站 开始并不多。从构建前期就必须做好,比如内容页的上一页和下一页,侧边栏的相关调用等等,都必须在内循环的构建中完成,合理的内链结构可以大大缩短。页面的收录时间,所以需要了解网站生态内部链规则。

五、网站地图

网站如果地图配置了很多后台程序自然生成的地图,就可以了。这是非常简单和必要的。

六、404 页

404页面我想大部分站长朋友都知道它的用途。站点中不存在或将不存在的所有页面都应指向该页面。404页面的设置是搜索引擎友好的一种形式。, 所以 网站 必须在开始构建时考虑在内。

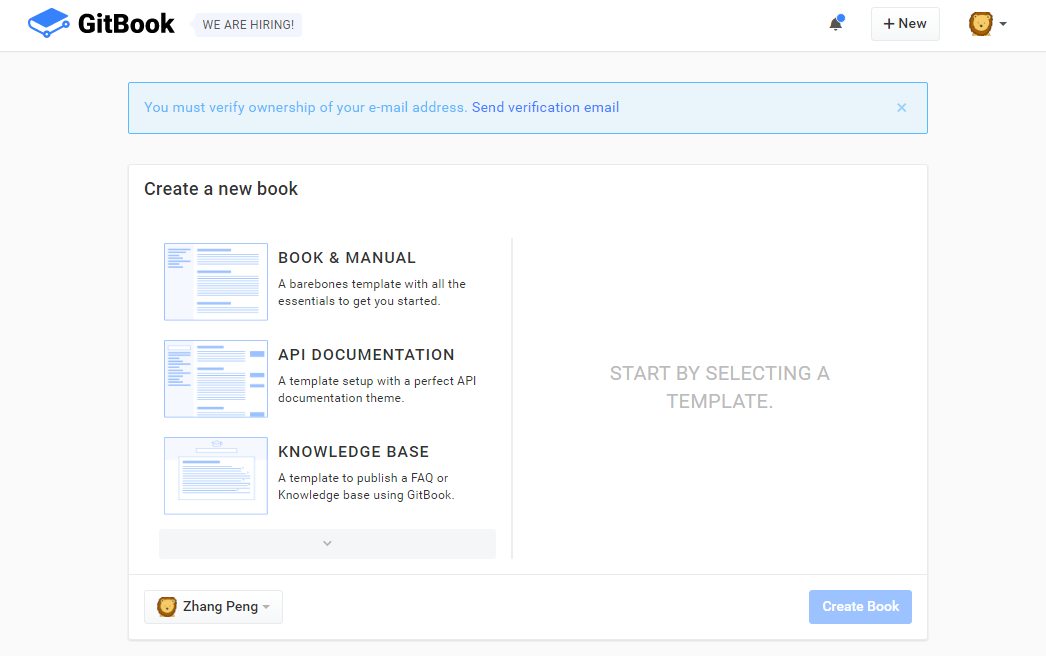

抓取网页生成电子书(Gitbook生成电子书的完整过程及安装、命令、配置、文档结构)

网站优化 • 优采云 发表了文章 • 0 个评论 • 182 次浏览 • 2022-04-11 06:19

本文详细讲解了从Gitbook生成电子书的完整流程,包括:安装、命令、配置、文档结构、电子书生成、部署。

限于篇幅,本文不介绍任何Gitbook定制页面的内容。

如果想看Gitbook在线电子书的效果,请点这里:gitbook-notes

概述

GitBook 是一个命令行工具(和 Node.js 库),用于使用 GitHub/Git 和 Markdown(或 AsciiDoc)构建精美的书籍。

GitBook 可以将您的内容输出为 网站(可自定义和可扩展)或电子书(PDF、ePub 或 Mobi)。

是一个使用 GitBook 格式创建和托管书籍的在线平台。它提供托管、协作功能和易于使用的编辑器。

GitBook安装本地安装环境要求

安装 GitBook 很简单。您的系统只需要满足这两个要求:

通过 npm 安装

安装 GitBook 的最佳方式是通过 NPM。在终端提示符下,只需运行以下命令即可安装 GitBook:

$ npm install gitbook-cli -g

gitbook-cli 是 GitBook 的命令行工具。它将自动安装所需版本的 GitBook 来构建一本书。

执行以下命令检查GitBook版本,验证安装成功。

$ gitbook -V

安装历史版本

gitbook-cli 可以轻松下载和安装其他版本的 GitBook 以测试您的书籍:

$ gitbook fetch beta

使用 gitbook ls-remote 将列出可下载的版本。

创建图书初始化

GitBook 可以设置样板书:

$ gitbook init

如果你想将这本书创建到一个新目录中,你可以通过运行 gitbook init ./directory 来实现。

构造

使用如下命令会在项目目录下生成一个_book目录,里面收录了静态站点的资源文件:

$ gitbook build

调试

您可以使用选项 --log=debug 和 --debug 来获得更好的错误消息(带有堆栈跟踪)。例如:

$ gitbook build ./ --log=debug --debug

启动服务

使用以下命令将运行一个可以通过 :4000/ 预览书籍的 Web 服务

$ gitbook serve

GitBook 命令

这里主要介绍GitBook的命令行工具gitbook-cli的一些命令。首先说明两点:

列出所有 gitbook 命令

gitbook help

输出 gitbook-cli 的帮助信息

gitbook --help

生成静态网页

gitbook build

生成静态网页并运行服务器

gitbook serve

生成时指定gitbook的版本,不会先下载到本地

gitbook build --gitbook=2.0.1

列出所有本地 gitbook 版本

gitbook ls

列出远程可用的 gitbook 版本

gitbook ls-remote

安装对应的gitbook版本

gitbook fetch 标签/版本号

更新到最新版本的 gitbook

gitbook update

卸载对应的gitbook版本

gitbook uninstall 2.0.1

指定日志级别

gitbook build --log=debug

输出错误信息

gitbook builid --debug

Gitbook 目录结构 GitBook 项目结构

GitBook 使用简单的目录结构。Summary 中列出的所有 Markdown / Asciidoc 文件(即 Summary.md 文件)都将转换为 HTML。多语种书籍的结构略有不同。

一个基本的 GitBook 电子书结构通常如下所示:

.

├── book.json

├── README.md

├── SUMMARY.md

├── chapter-1/

| ├── README.md

| └── something.md

└── chapter-2/

├── README.md

└── something.md

GitBook 特殊文件的特点:

文件描述

book.json

配置数据(可选)

自述文件.md

电子书的前言或介绍(必填)

摘要.md

电子书目录(可选)

词汇表.md

词汇表/评论术语列表(可选)

静态文件和图像

静态文件是未在 Summary.md 中列出的文件。除非被忽略,否则所有静态文件都将复制到输出路径。

忽略文件和文件夹

GitBook 将读取 .gitignore、.bookignore 和 .ignore 文件来过滤文件和文件夹。这些文件中的格式遵循 .gitignore 的规则:

# This is a comment

# Ignore the file test.md

test.md

# Ignore everything in the directory "bin"

bin/*

项目和子目录集成

对于软件项目,您可以使用 docs/ 等子目录来存储项目的书籍文档。您可以配置 root 选项以指示 GitBook 可以在其中找到图书文件的文件夹:

.

├── book.json

└── docs/

├── README.md

└── SUMMARY.md

在 book.json 中配置以下内容:

{

"root": "./docs"

}

概括

GitBook 使用SUMMARY.md 文件来定义本书的章节和子章节结构。Summary.md 文件用于生成本书的目录。

Summary.md 的格式是一个链表。链接的标题将是章节的标题,链接的目标是该章节文件的路径。

将嵌套列表添加到父章节将创建子章节。

简单的例子:

# Summary

* [Part I](part1/README.md)

* [Writing is nice](part1/writing.md)

* [GitBook is nice](part1/gitbook.md)

* [Part II](part2/README.md)

* [We love feedback](part2/feedback_please.md)

* [Better tools for authors](part2/better_tools.md)

每章都有一个专门的页面(part#/README.md)并分为小节。

锚

目录中的章节可以使用锚点来指向文件的特定部分。

# Summary

### Part I

* [Part I](part1/README.md)

* [Writing is nice](part1/README.md#writing)

* [GitBook is nice](part1/README.md#gitbook)

* [Part II](part2/README.md)

* [We love feedback](part2/README.md#feedback)

* [Better tools for authors](part2/README.md#tools)

部分

目录可以分为由标题或水平线分隔的部分----:

# Summary

### Part I

* [Writing is nice](part1/writing.md)

* [GitBook is nice](part1/gitbook.md)

### Part II

* [We love feedback](part2/feedback_please.md)

* [Better tools for authors](part2/better_tools.md)

----

* [Last part without title](part3/title.md)

部分只是章节组,没有专门的页面,但根据主题,它会显示在导航中。

页

降价语法

默认情况下,GitBook 的大部分文件都使用 Markdown 语法。GitBook 推荐这种语法。使用的语法类似于 GitHub Flavored Markdown 语法。

此外,您可以选择 AsciiDoc 语法。

页面内容示例:

# Title of the chapter

This is a great introduction.

## Section 1

Markdown will dictates _most_ of your **book's structure**

## Section 2

...

页前言

页面可以收录可选的前言。它可以用来定义页面的描述。前面的内容必须是文件中的第一个内容,并且必须采用在三段虚线之间设置的有效 YAML 的形式。这是一个基本示例:

---

description: This is a short description of my page

---

# The content of my page

...

词汇表

允许您指定术语及其各自的定义以显示为注释。基于这些术语,GitBook 将自动构建索引并突出显示它们。

GLOSSARY.md 的格式是 h2 标题列表和描述段落:

## Term

Definition for this term

## Another term

With it's definition, this can contain bold text

and all other kinds of inline markup ...

Gitbook 配置

GitBook 允许您使用灵活的配置自定义您的电子书。

这些选项在 book.json 文件中指定。对于不熟悉 JSON 语法的作者,可以使用 JSONlint 等工具来验证语法。

常规设置变量描述

根

收录除 book.json 之外的所有书籍文件的根文件夹的路径

结构体

指定自述文件、摘要、词汇表等参考的路径。

标题

您的书名,默认值是从 README 中提取的。在 上,此字段已预先填写。

描述

你的书的描述,默认值是从自述文件中提取的。在 上,此字段已预先填写。

作者

作者姓名。在 上,此字段已预先填写。

伊斯本

国际标准书号 ISBN

语言

本书的语言类型——ISO 代码。默认值为 en

方向

文本阅读顺序。可以是 rtl(从右到左)或 ltr(从左到右),默认值取决于语言的值。

gitbook

应该使用的 GitBook 版本。使用 SemVer 规范并接受 ">= 3.0.0" 之类的条件。

作者

作者姓名,on ,该字段是预填的。

例子:

"author" : "victor zhang"

描述

eBook 的描述,默认值是从 README 中提取的。在 上,此字段已预先填写。

例子:

"description" : "Gitbook 教程"

方向

文本的方向。可以是 rtl 或 ltr,默认值取决于语言值。

例子:

"direction" : "ltr"

gitbook

应该使用的 GitBook 版本。使用 SemVer 规范,接受 >=3.0.0 之类的条件。

例子:

"gitbook" : "3.0.0",

"gitbook" : ">=3.0.0"

语言

Gitbook使用的语言,2.6.4版本可选语言如下:

en, ar, bn, cs, de, en, es, fa, fi, fr, he, it, ja, ko, no, pl, pt, ro, ru, sv, uk, vi, zh-hans, zh-tw

例子:

"language" : "zh-hans",

链接

在左侧导航栏中添加链接信息

例子:

"links" : {

"sidebar" : {

"Home" : "https://github.com/atlantis102 ... ot%3B

}

}

根

收录所有书籍文件的根文件夹的路径,除了 book.json 文件。

例子:

"root" : "./docs",

结构体

指定自述文件、摘要、词汇表和语言的文件名。

风格

自定义页面样式,默认每个生成器对应的css文件

例子:

"styles": {

"website": "styles/website.css",

"ebook": "styles/ebook.css",

"pdf": "styles/pdf.css",

"mobi": "styles/mobi.css",

"epub": "styles/epub.css"

}

例如,要让 h1、h2 标签有下边框,可以在 website.css 中设置

h1 , h2{

border-bottom: 1px solid #EFEAEA;

}

标题

电子书的标题,默认值是从README中提取的。在 上,此字段已预先填写。

例子:

"title" : "gitbook-notes",

插件

插件及其配置在 book.json 中指定。了解更多信息。

GitBook 可以使用自版本 3.0.0 起的主题。有关详细信息,请参阅主题部分。

变量描述

插件

要加载的插件列表

插件配置

插件配置

添加插件

"plugins": [

"splitter"

]

添加新插件后,需要运行 gitbook install 来安装新插件

删除内置插件

Gitbook 默认自带 5 个插件:

"plugins": [

"-search"

]

结构体

除了root属性,还可以指定Readme、Summary、Glossary、Languages的名称(而不是使用默认名称,比如README.md)。这些文件必须位于项目的根目录(或根目录,如果您在 book.json 中配置了 root 属性)。不可接受的路径,例如:dir/MY_README.md。

变量描述

结构.readme

自述文件名(默认为 README.md)

结构.摘要

摘要文件名(默认为SUMMARY.md)

结构.词汇表

词汇表文件名(默认为 GLOSSARY.md)

结构语言

语言文件名(默认为 LANGS.md)

可以使用 book.json 中的一组选项自定义 PDF 输出:

变量描述

pdf.pageNumbers

在每页底部添加页码(默认为 true)

pdf.fontSize

基本字体大小(默认为 12)

pdf.fontFamily

基本字体样式(默认为 Arial)

pdf.paperSize

页面大小,选项有:'a0'、'a1'、'a2'、'a3'、'a4'、'a5'、'a6'、'b0'、'b1'、'b2'、'b3'、 'b4', 'b5', 'b6', 'legal', 'letter' (默认是a4)

上限(默认为 56)

pdf.margin.bottom

下限(默认为 56)

pdf.margin.right

右边框(默认为 62)

pdf.margin.left

左边框(默认为 62)

生成电子书

GitBook 可以生成 网站,但也可以将内容输出为电子书(ePub、Mobi、PDF)。

# Generate a PDF file

$ gitbook pdf ./ ./mybook.pdf

# Generate an ePub file

$ gitbook epub ./ ./mybook.epub

# Generate a Mobi file

$ gitbook mobi ./ ./mybook.mobi

安装电子书转换

ebook-convert 可用于生成电子书(epub、mobi、pdf)。

GNU/Linux

安装口径应用程序。

$ sudo aptitude install calibre

在某些 GNU/Linux 发行版上,node 安装为 nodejs,您需要手动创建符号链接:

$sudo ln -s /usr/bin/nodejs /usr/bin/node

操作系统

下载口径应用程序。将 calibre.app 移动到应用程序文件夹后,创建指向 ebook-convert 工具的符号链接:

$ sudo ln -s ~/Applications/calibre.app/Contents/MacOS/ebook-convert /usr/bin

您可以将 /usr/bin 替换为 $PATH 中的任何目录。

覆盖

封面用于所有电子书格式。您可以自己提供一个或使用自动覆盖插件生成一个。

要提供封面,请将 cover.jpg 文件放在本书的根目录中。添加一个cover_small.jpg 将指定一个较小版本的封面。封面应该是 JPEG 文件。

一个好的封面应该遵循以下准则:

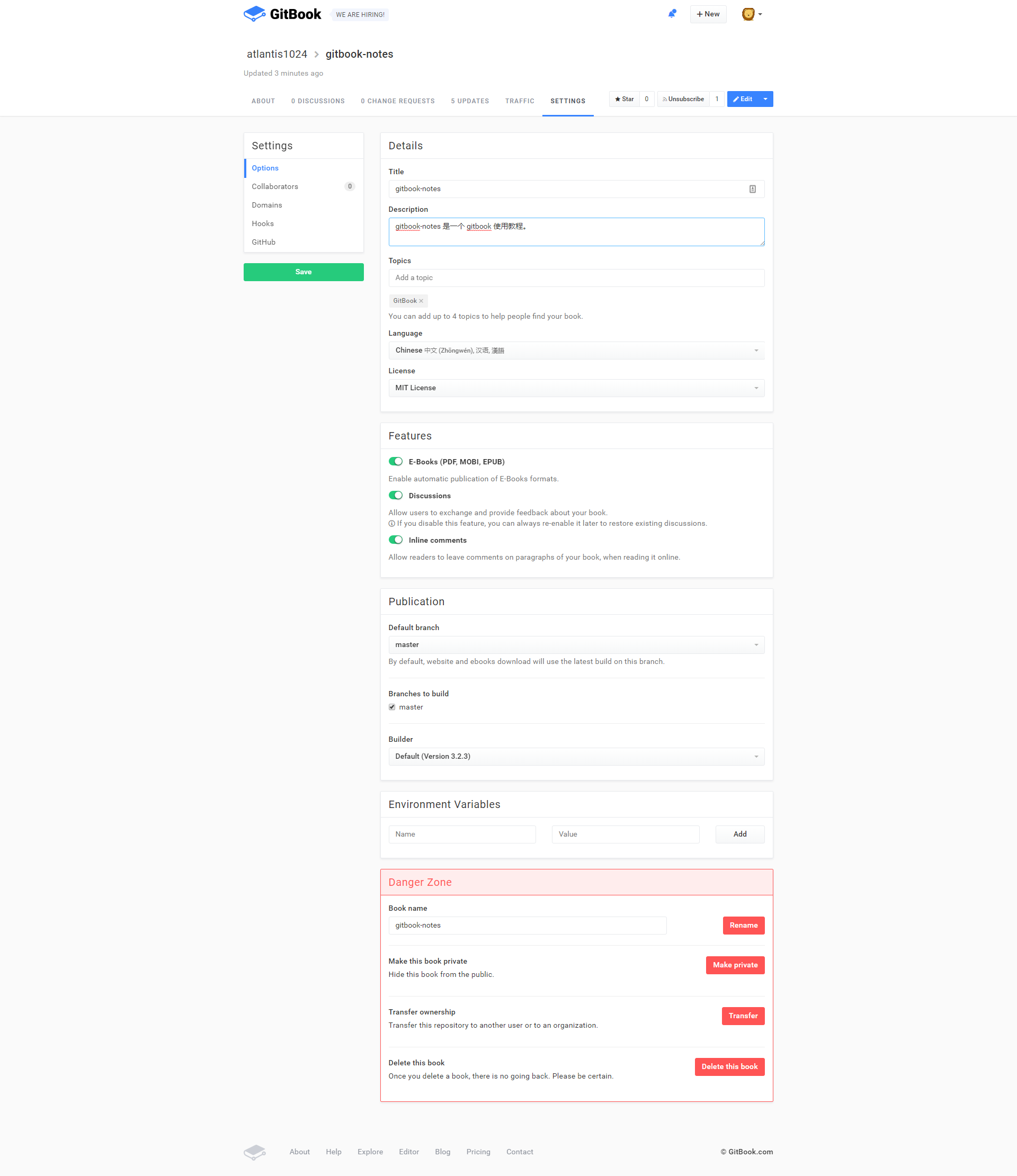

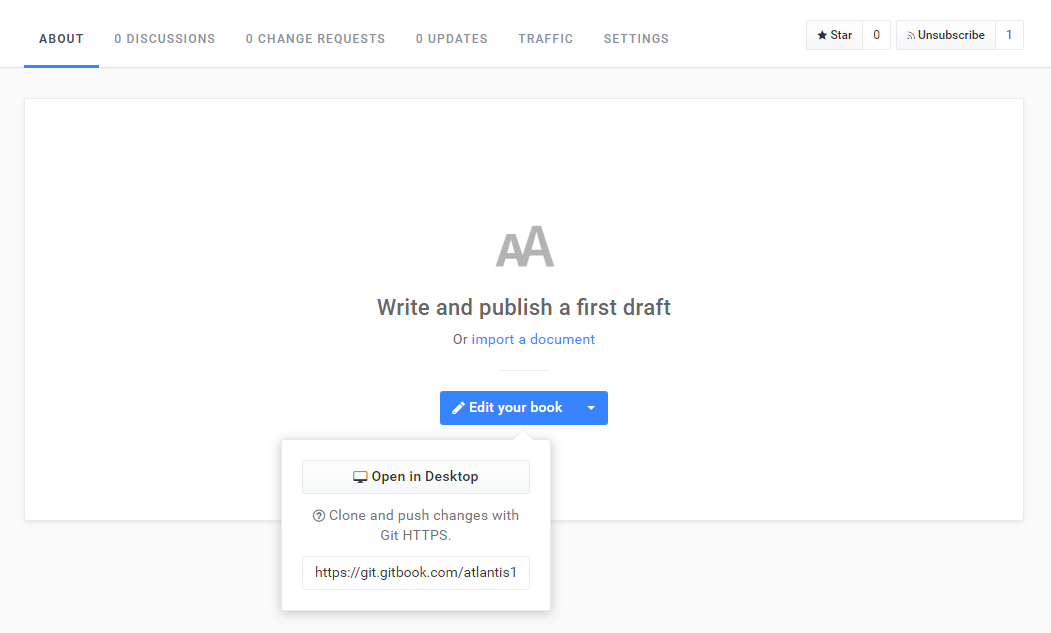

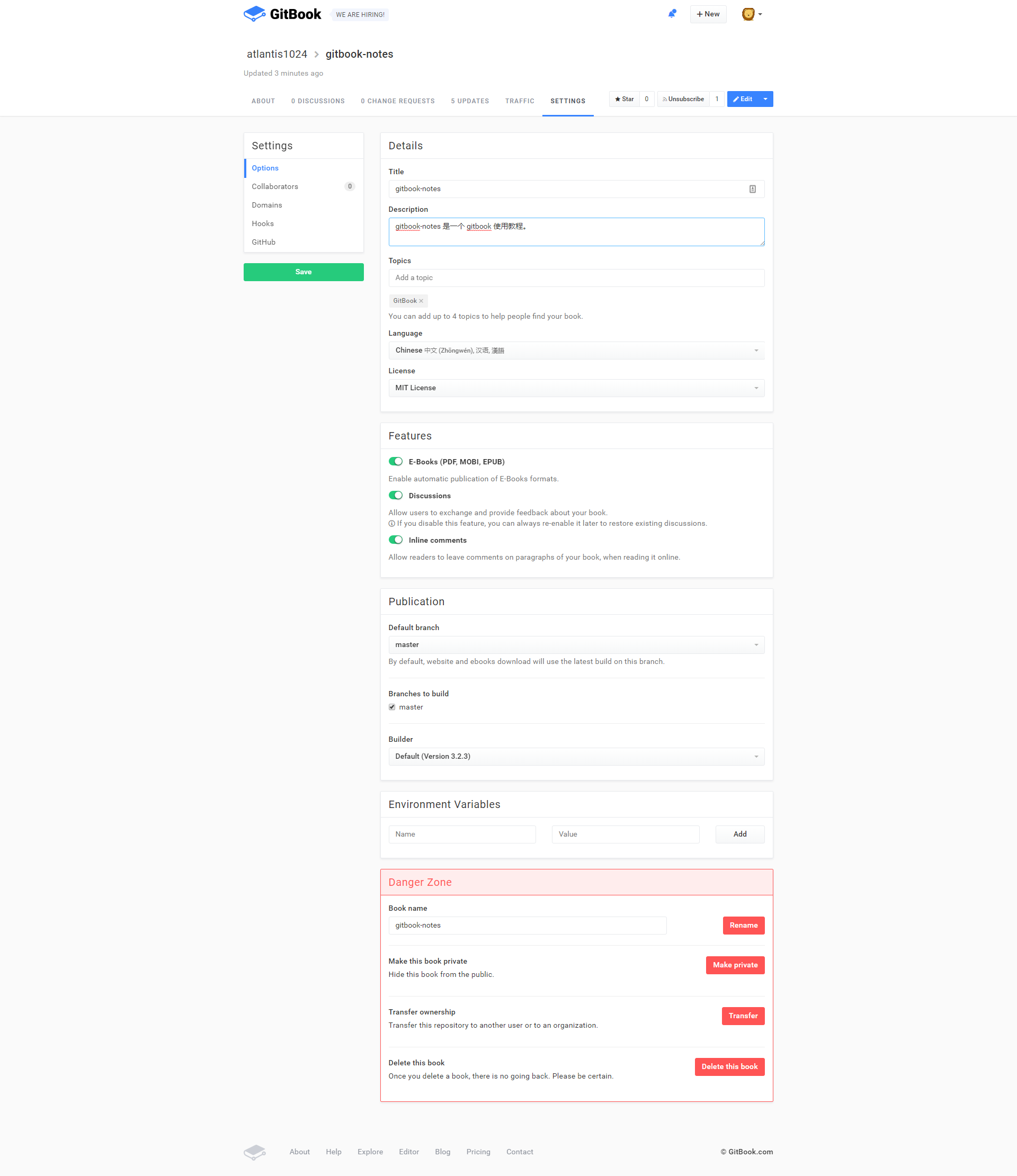

Gitbook 部署托管到

是一个使用 GitBook 格式创建和托管书籍的在线平台。它提供托管、协作功能和易于使用的编辑器。

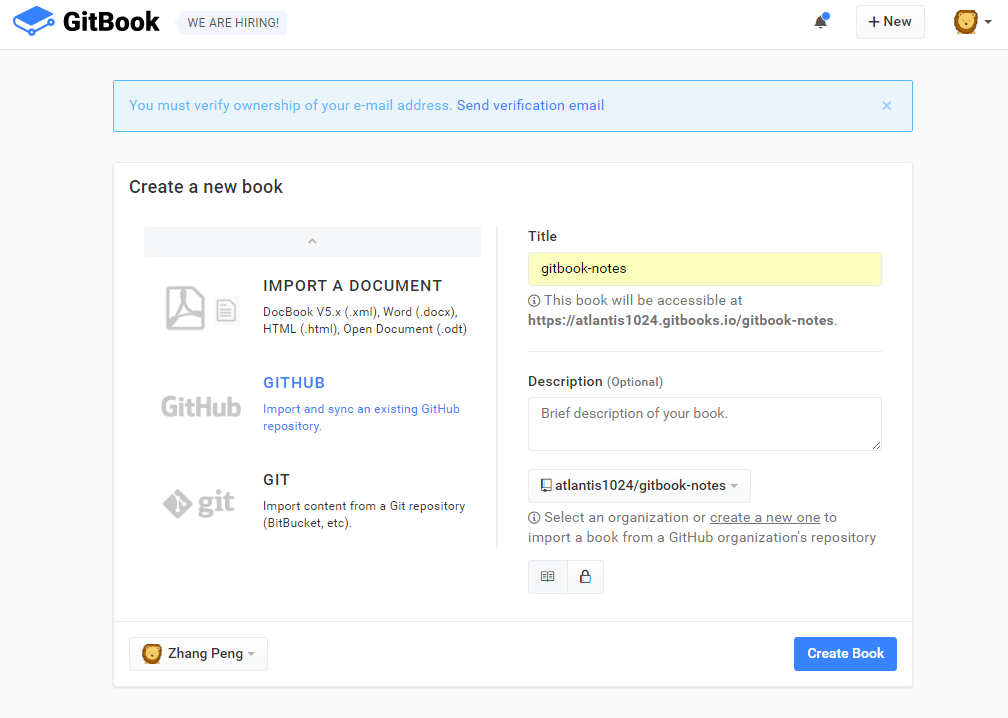

创建新书

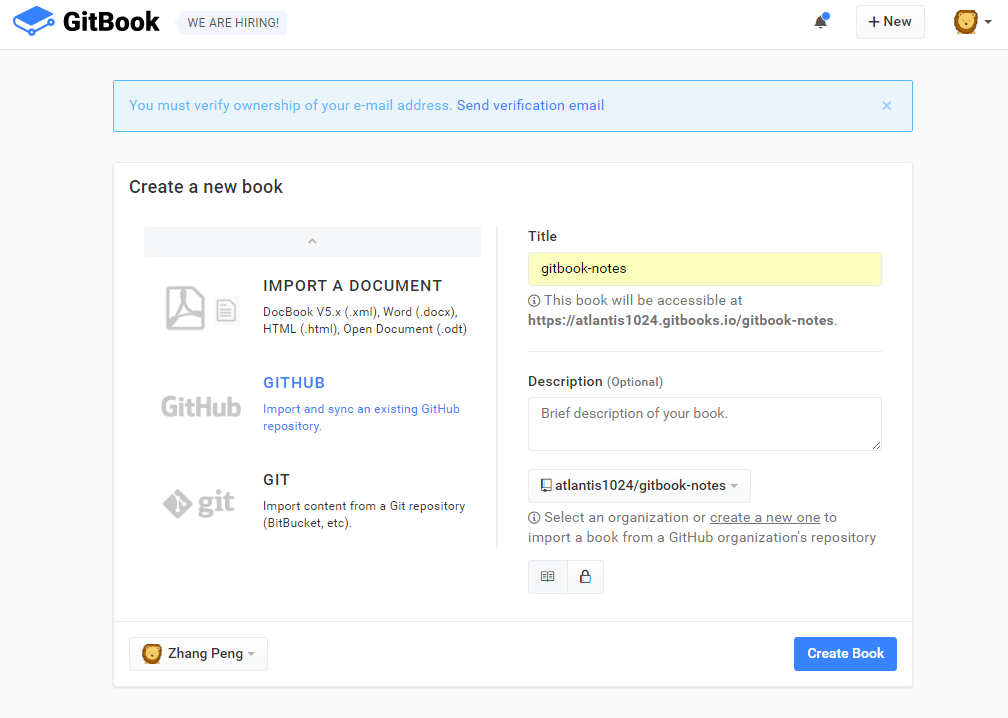

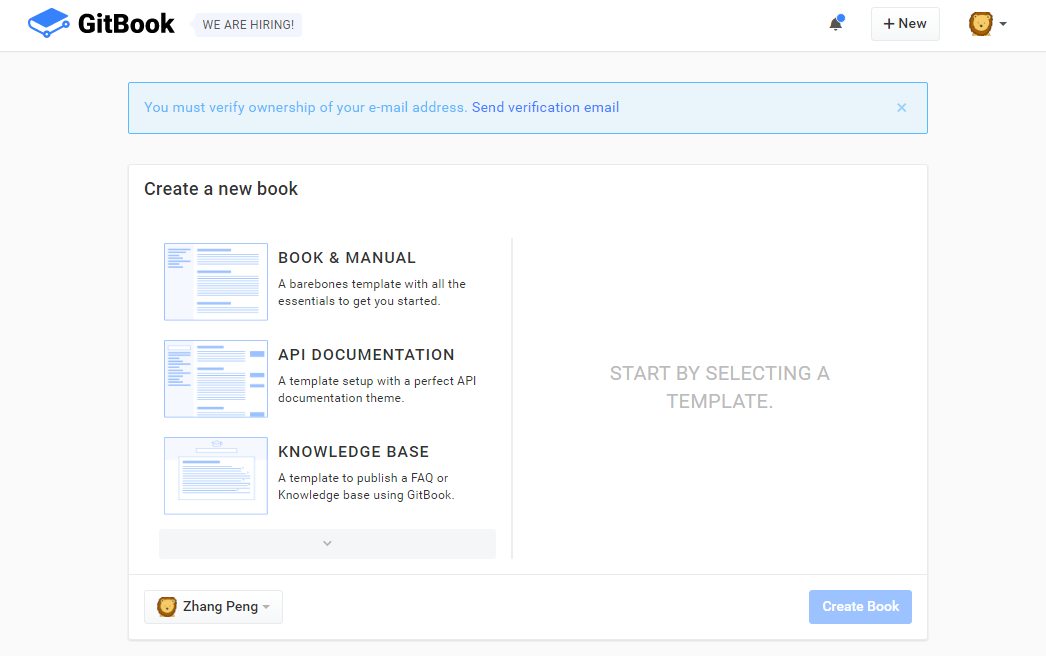

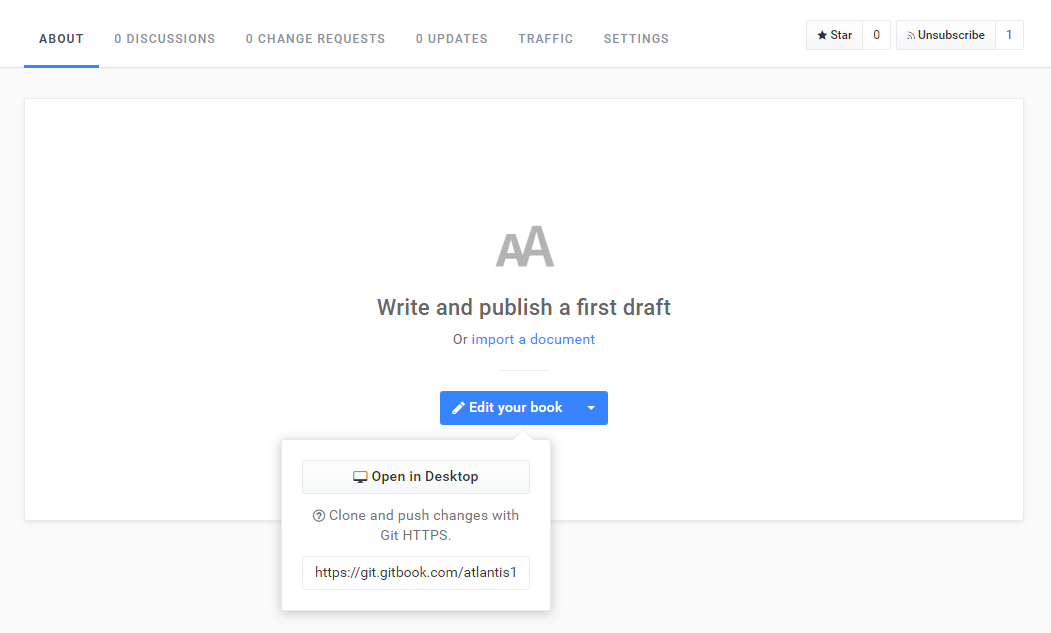

如下图所示,根据您的个人需求,选择一个模板来创建您的电子书。

设置图书基本信息

克隆到本地

将为每本书创建一个 git 存储库。

如下图,复制git地址,然后git clone到本地。

释放

根据 Gitbook 规范在本地编辑电子书,然后 git push 到 Gitbook 远程仓库。

默认访问地址为:username.gitbooks.io/projectname/content/

例如:我的用户名为atlantis1024,一个电子书项目名为test,那么访问路径为:

当然,如果你有自己的域名,你也可以设置 Domains 选项来指定你的域的访问路径。

托管在 Github 上

如果你不想使用 Gitbook 的仓库,但想直接使用 Github 的仓库,也是可以的。

首先,你需要绑定你的 Github 账号。最简单的方法当然是在登录的时候使用Github账号登录方式,否则也可以在Account Settings中的Github设置选项中进行绑定。

绑定 Github 账号后,您可以在创建电子书时选择从指定的 Github 仓库导入电子书项目。请参考下图:

只要您指定的 Github 仓库中的文档内容符合 Gitbook 规范,Gitbook 就会根据您的每次更新自动构建并生成电子书网站。

默认访问地址为:

https://Github用户名.gitbooks.io/Github 仓库/content/

例如:我的用户名是atlantis1024,Github仓库名是gitbook-notes,那么访问路径是:

托管到 Github 页面

或许你之前也知道 Github 的一个特性:GitHub Pages。它允许用户在 GitHub 存储库中托管您的个人、组织或项目的静态页面(自动识别 html、css、javascript)。

构建 xxx.github.io 仓库

要使用这个功能,首先要创建一个严格遵循命名要求的仓库:Github账号名.github.io 比如我的Github账号是atlantis1024,那么这个仓库应该叫atlantis1024.github.io . 通常,此存储库用作个人或组织博客。

创建 gh-pages 分支

完成步骤 1 后,在任何 Github 存储库中创建一个名为 gh-pages 的分支。只要 gh-pages 中的内容满足静态站点要求,就可以在如下地址访问:username.gitbooks.io/Github 仓库。例如:我的 Github 仓库之一名为 react-notes,访问路径为:

自动发布到 gh-pages

如果每次手动 git push 到远程的 gh-pages 分支,就有点麻烦了。

如何实现自动发布?

有两种方法:

使用 gh-pages 插件

如果您了解 Nodejs,最简单的发布方式是使用 gh-pages 插件。

先在本地安装插件

$ npm i -D gh-pages

然后,在 package.json 文件中添加脚本命令:

如下: -d 命令参数后跟要发布的静态站点内容的目录

"scripts": {

"deploy": "gh-pages -d build"

},

脚本

编写一个执行 git 命令的脚本,你就完成了。

以下脚本可以在 bat 或 sh 脚本中执行。

cd build

git init

git checkout -b gh-pages

git add .

git commit -am "Update"

git push git@github.com:atlantis1024/gitbook-notes gh-pages --force"

资源 官方资源 教程 资源工具 查看全部

抓取网页生成电子书(Gitbook生成电子书的完整过程及安装、命令、配置、文档结构)

本文详细讲解了从Gitbook生成电子书的完整流程,包括:安装、命令、配置、文档结构、电子书生成、部署。

限于篇幅,本文不介绍任何Gitbook定制页面的内容。

如果想看Gitbook在线电子书的效果,请点这里:gitbook-notes

概述

GitBook 是一个命令行工具(和 Node.js 库),用于使用 GitHub/Git 和 Markdown(或 AsciiDoc)构建精美的书籍。

GitBook 可以将您的内容输出为 网站(可自定义和可扩展)或电子书(PDF、ePub 或 Mobi)。

是一个使用 GitBook 格式创建和托管书籍的在线平台。它提供托管、协作功能和易于使用的编辑器。

GitBook安装本地安装环境要求

安装 GitBook 很简单。您的系统只需要满足这两个要求:

通过 npm 安装

安装 GitBook 的最佳方式是通过 NPM。在终端提示符下,只需运行以下命令即可安装 GitBook:

$ npm install gitbook-cli -g

gitbook-cli 是 GitBook 的命令行工具。它将自动安装所需版本的 GitBook 来构建一本书。

执行以下命令检查GitBook版本,验证安装成功。

$ gitbook -V

安装历史版本

gitbook-cli 可以轻松下载和安装其他版本的 GitBook 以测试您的书籍:

$ gitbook fetch beta

使用 gitbook ls-remote 将列出可下载的版本。

创建图书初始化

GitBook 可以设置样板书:

$ gitbook init

如果你想将这本书创建到一个新目录中,你可以通过运行 gitbook init ./directory 来实现。

构造

使用如下命令会在项目目录下生成一个_book目录,里面收录了静态站点的资源文件:

$ gitbook build

调试

您可以使用选项 --log=debug 和 --debug 来获得更好的错误消息(带有堆栈跟踪)。例如:

$ gitbook build ./ --log=debug --debug

启动服务

使用以下命令将运行一个可以通过 :4000/ 预览书籍的 Web 服务

$ gitbook serve

GitBook 命令

这里主要介绍GitBook的命令行工具gitbook-cli的一些命令。首先说明两点:

列出所有 gitbook 命令

gitbook help

输出 gitbook-cli 的帮助信息

gitbook --help

生成静态网页

gitbook build

生成静态网页并运行服务器

gitbook serve

生成时指定gitbook的版本,不会先下载到本地

gitbook build --gitbook=2.0.1

列出所有本地 gitbook 版本

gitbook ls

列出远程可用的 gitbook 版本

gitbook ls-remote

安装对应的gitbook版本

gitbook fetch 标签/版本号

更新到最新版本的 gitbook

gitbook update

卸载对应的gitbook版本

gitbook uninstall 2.0.1

指定日志级别

gitbook build --log=debug

输出错误信息

gitbook builid --debug

Gitbook 目录结构 GitBook 项目结构

GitBook 使用简单的目录结构。Summary 中列出的所有 Markdown / Asciidoc 文件(即 Summary.md 文件)都将转换为 HTML。多语种书籍的结构略有不同。

一个基本的 GitBook 电子书结构通常如下所示:

.

├── book.json

├── README.md

├── SUMMARY.md

├── chapter-1/

| ├── README.md

| └── something.md

└── chapter-2/

├── README.md

└── something.md

GitBook 特殊文件的特点:

文件描述

book.json

配置数据(可选)

自述文件.md

电子书的前言或介绍(必填)

摘要.md

电子书目录(可选)

词汇表.md

词汇表/评论术语列表(可选)

静态文件和图像

静态文件是未在 Summary.md 中列出的文件。除非被忽略,否则所有静态文件都将复制到输出路径。

忽略文件和文件夹

GitBook 将读取 .gitignore、.bookignore 和 .ignore 文件来过滤文件和文件夹。这些文件中的格式遵循 .gitignore 的规则:

# This is a comment

# Ignore the file test.md

test.md

# Ignore everything in the directory "bin"

bin/*

项目和子目录集成

对于软件项目,您可以使用 docs/ 等子目录来存储项目的书籍文档。您可以配置 root 选项以指示 GitBook 可以在其中找到图书文件的文件夹:

.

├── book.json

└── docs/

├── README.md

└── SUMMARY.md

在 book.json 中配置以下内容:

{

"root": "./docs"

}

概括

GitBook 使用SUMMARY.md 文件来定义本书的章节和子章节结构。Summary.md 文件用于生成本书的目录。

Summary.md 的格式是一个链表。链接的标题将是章节的标题,链接的目标是该章节文件的路径。

将嵌套列表添加到父章节将创建子章节。

简单的例子:

# Summary

* [Part I](part1/README.md)

* [Writing is nice](part1/writing.md)

* [GitBook is nice](part1/gitbook.md)

* [Part II](part2/README.md)

* [We love feedback](part2/feedback_please.md)

* [Better tools for authors](part2/better_tools.md)

每章都有一个专门的页面(part#/README.md)并分为小节。

锚

目录中的章节可以使用锚点来指向文件的特定部分。

# Summary

### Part I

* [Part I](part1/README.md)

* [Writing is nice](part1/README.md#writing)

* [GitBook is nice](part1/README.md#gitbook)

* [Part II](part2/README.md)

* [We love feedback](part2/README.md#feedback)

* [Better tools for authors](part2/README.md#tools)

部分

目录可以分为由标题或水平线分隔的部分----:

# Summary

### Part I

* [Writing is nice](part1/writing.md)

* [GitBook is nice](part1/gitbook.md)

### Part II

* [We love feedback](part2/feedback_please.md)

* [Better tools for authors](part2/better_tools.md)

----

* [Last part without title](part3/title.md)

部分只是章节组,没有专门的页面,但根据主题,它会显示在导航中。

页

降价语法

默认情况下,GitBook 的大部分文件都使用 Markdown 语法。GitBook 推荐这种语法。使用的语法类似于 GitHub Flavored Markdown 语法。

此外,您可以选择 AsciiDoc 语法。

页面内容示例:

# Title of the chapter

This is a great introduction.

## Section 1

Markdown will dictates _most_ of your **book's structure**

## Section 2

...

页前言

页面可以收录可选的前言。它可以用来定义页面的描述。前面的内容必须是文件中的第一个内容,并且必须采用在三段虚线之间设置的有效 YAML 的形式。这是一个基本示例:

---

description: This is a short description of my page

---

# The content of my page

...

词汇表

允许您指定术语及其各自的定义以显示为注释。基于这些术语,GitBook 将自动构建索引并突出显示它们。

GLOSSARY.md 的格式是 h2 标题列表和描述段落:

## Term

Definition for this term

## Another term

With it's definition, this can contain bold text

and all other kinds of inline markup ...

Gitbook 配置

GitBook 允许您使用灵活的配置自定义您的电子书。

这些选项在 book.json 文件中指定。对于不熟悉 JSON 语法的作者,可以使用 JSONlint 等工具来验证语法。

常规设置变量描述

根

收录除 book.json 之外的所有书籍文件的根文件夹的路径

结构体

指定自述文件、摘要、词汇表等参考的路径。

标题

您的书名,默认值是从 README 中提取的。在 上,此字段已预先填写。

描述

你的书的描述,默认值是从自述文件中提取的。在 上,此字段已预先填写。

作者

作者姓名。在 上,此字段已预先填写。

伊斯本

国际标准书号 ISBN

语言

本书的语言类型——ISO 代码。默认值为 en

方向

文本阅读顺序。可以是 rtl(从右到左)或 ltr(从左到右),默认值取决于语言的值。

gitbook

应该使用的 GitBook 版本。使用 SemVer 规范并接受 ">= 3.0.0" 之类的条件。

作者

作者姓名,on ,该字段是预填的。

例子:

"author" : "victor zhang"

描述

eBook 的描述,默认值是从 README 中提取的。在 上,此字段已预先填写。

例子:

"description" : "Gitbook 教程"

方向

文本的方向。可以是 rtl 或 ltr,默认值取决于语言值。

例子:

"direction" : "ltr"

gitbook

应该使用的 GitBook 版本。使用 SemVer 规范,接受 >=3.0.0 之类的条件。

例子:

"gitbook" : "3.0.0",

"gitbook" : ">=3.0.0"

语言

Gitbook使用的语言,2.6.4版本可选语言如下:

en, ar, bn, cs, de, en, es, fa, fi, fr, he, it, ja, ko, no, pl, pt, ro, ru, sv, uk, vi, zh-hans, zh-tw

例子:

"language" : "zh-hans",

链接

在左侧导航栏中添加链接信息

例子:

"links" : {

"sidebar" : {

"Home" : "https://github.com/atlantis102 ... ot%3B

}

}

根

收录所有书籍文件的根文件夹的路径,除了 book.json 文件。

例子:

"root" : "./docs",

结构体

指定自述文件、摘要、词汇表和语言的文件名。

风格

自定义页面样式,默认每个生成器对应的css文件

例子:

"styles": {

"website": "styles/website.css",

"ebook": "styles/ebook.css",

"pdf": "styles/pdf.css",

"mobi": "styles/mobi.css",

"epub": "styles/epub.css"

}

例如,要让 h1、h2 标签有下边框,可以在 website.css 中设置

h1 , h2{

border-bottom: 1px solid #EFEAEA;

}

标题

电子书的标题,默认值是从README中提取的。在 上,此字段已预先填写。

例子:

"title" : "gitbook-notes",

插件

插件及其配置在 book.json 中指定。了解更多信息。

GitBook 可以使用自版本 3.0.0 起的主题。有关详细信息,请参阅主题部分。

变量描述

插件

要加载的插件列表

插件配置

插件配置

添加插件

"plugins": [

"splitter"

]

添加新插件后,需要运行 gitbook install 来安装新插件

删除内置插件

Gitbook 默认自带 5 个插件:

"plugins": [

"-search"

]

结构体

除了root属性,还可以指定Readme、Summary、Glossary、Languages的名称(而不是使用默认名称,比如README.md)。这些文件必须位于项目的根目录(或根目录,如果您在 book.json 中配置了 root 属性)。不可接受的路径,例如:dir/MY_README.md。

变量描述

结构.readme

自述文件名(默认为 README.md)

结构.摘要

摘要文件名(默认为SUMMARY.md)

结构.词汇表

词汇表文件名(默认为 GLOSSARY.md)

结构语言

语言文件名(默认为 LANGS.md)

可以使用 book.json 中的一组选项自定义 PDF 输出:

变量描述

pdf.pageNumbers

在每页底部添加页码(默认为 true)

pdf.fontSize

基本字体大小(默认为 12)

pdf.fontFamily

基本字体样式(默认为 Arial)

pdf.paperSize

页面大小,选项有:'a0'、'a1'、'a2'、'a3'、'a4'、'a5'、'a6'、'b0'、'b1'、'b2'、'b3'、 'b4', 'b5', 'b6', 'legal', 'letter' (默认是a4)

上限(默认为 56)

pdf.margin.bottom

下限(默认为 56)

pdf.margin.right

右边框(默认为 62)

pdf.margin.left

左边框(默认为 62)

生成电子书

GitBook 可以生成 网站,但也可以将内容输出为电子书(ePub、Mobi、PDF)。

# Generate a PDF file

$ gitbook pdf ./ ./mybook.pdf

# Generate an ePub file

$ gitbook epub ./ ./mybook.epub

# Generate a Mobi file

$ gitbook mobi ./ ./mybook.mobi

安装电子书转换

ebook-convert 可用于生成电子书(epub、mobi、pdf)。

GNU/Linux

安装口径应用程序。

$ sudo aptitude install calibre

在某些 GNU/Linux 发行版上,node 安装为 nodejs,您需要手动创建符号链接:

$sudo ln -s /usr/bin/nodejs /usr/bin/node

操作系统

下载口径应用程序。将 calibre.app 移动到应用程序文件夹后,创建指向 ebook-convert 工具的符号链接:

$ sudo ln -s ~/Applications/calibre.app/Contents/MacOS/ebook-convert /usr/bin

您可以将 /usr/bin 替换为 $PATH 中的任何目录。

覆盖

封面用于所有电子书格式。您可以自己提供一个或使用自动覆盖插件生成一个。

要提供封面,请将 cover.jpg 文件放在本书的根目录中。添加一个cover_small.jpg 将指定一个较小版本的封面。封面应该是 JPEG 文件。

一个好的封面应该遵循以下准则:

Gitbook 部署托管到

是一个使用 GitBook 格式创建和托管书籍的在线平台。它提供托管、协作功能和易于使用的编辑器。

创建新书

如下图所示,根据您的个人需求,选择一个模板来创建您的电子书。

设置图书基本信息

克隆到本地

将为每本书创建一个 git 存储库。

如下图,复制git地址,然后git clone到本地。

释放

根据 Gitbook 规范在本地编辑电子书,然后 git push 到 Gitbook 远程仓库。

默认访问地址为:username.gitbooks.io/projectname/content/

例如:我的用户名为atlantis1024,一个电子书项目名为test,那么访问路径为:

当然,如果你有自己的域名,你也可以设置 Domains 选项来指定你的域的访问路径。

托管在 Github 上

如果你不想使用 Gitbook 的仓库,但想直接使用 Github 的仓库,也是可以的。

首先,你需要绑定你的 Github 账号。最简单的方法当然是在登录的时候使用Github账号登录方式,否则也可以在Account Settings中的Github设置选项中进行绑定。

绑定 Github 账号后,您可以在创建电子书时选择从指定的 Github 仓库导入电子书项目。请参考下图:

只要您指定的 Github 仓库中的文档内容符合 Gitbook 规范,Gitbook 就会根据您的每次更新自动构建并生成电子书网站。

默认访问地址为:

https://Github用户名.gitbooks.io/Github 仓库/content/

例如:我的用户名是atlantis1024,Github仓库名是gitbook-notes,那么访问路径是:

托管到 Github 页面

或许你之前也知道 Github 的一个特性:GitHub Pages。它允许用户在 GitHub 存储库中托管您的个人、组织或项目的静态页面(自动识别 html、css、javascript)。

构建 xxx.github.io 仓库

要使用这个功能,首先要创建一个严格遵循命名要求的仓库:Github账号名.github.io 比如我的Github账号是atlantis1024,那么这个仓库应该叫atlantis1024.github.io . 通常,此存储库用作个人或组织博客。

创建 gh-pages 分支

完成步骤 1 后,在任何 Github 存储库中创建一个名为 gh-pages 的分支。只要 gh-pages 中的内容满足静态站点要求,就可以在如下地址访问:username.gitbooks.io/Github 仓库。例如:我的 Github 仓库之一名为 react-notes,访问路径为:

自动发布到 gh-pages

如果每次手动 git push 到远程的 gh-pages 分支,就有点麻烦了。

如何实现自动发布?

有两种方法:

使用 gh-pages 插件

如果您了解 Nodejs,最简单的发布方式是使用 gh-pages 插件。

先在本地安装插件

$ npm i -D gh-pages

然后,在 package.json 文件中添加脚本命令:

如下: -d 命令参数后跟要发布的静态站点内容的目录

"scripts": {

"deploy": "gh-pages -d build"

},

脚本

编写一个执行 git 命令的脚本,你就完成了。

以下脚本可以在 bat 或 sh 脚本中执行。

cd build

git init

git checkout -b gh-pages

git add .

git commit -am "Update"

git push git@github.com:atlantis1024/gitbook-notes gh-pages --force"

资源 官方资源 教程 资源工具

抓取网页生成电子书( 的“我的E站”设计制作)

网站优化 • 优采云 发表了文章 • 0 个评论 • 114 次浏览 • 2022-04-11 04:24

的“我的E站”设计制作)

本书采用的“我的E站”项目的设计与制作,为读者全面展示了网站设计与网页制作的基础知识,让没有网页制作基础知识的读者也能轻松上手。发展和产生自己的想法。网站 的。本书遵循网站开发的大致流程,主要介绍网站前期规划;网站结构创建;网页界面设计;简单的图像处理;图像和文本、列表、表格、模板和表单 DIV+CSS 标准布局;CSS 样式应用程序;多媒体和 Flash 应用程序;JavaScript 基础应用;网站创建和上传;网站 兼容性测试;文书写作;响应式设计等。本书免费提供书中所有资料。此外,全国计算机信息高技术考试高级网页制作人员网页制作技能强化综合练习题8套。技能强化培训材料均为原创作品以上资源可从华信教育资源网()下载。同时附有微课视频,可在书内二维码扫描学习。本书是专为高等职业教育计算机、美术设计、电子商务专业的网站设计与网页制作课程的专业教材。也可以作为高级网页制作者的培训教材。全国计算机信息高技术高级网页制作人员考试网页制作技能强化综合练习题8套。技能强化培训材料均为原创作品以上资源可从华信教育资源网()下载。同时附有微课视频,可在书内二维码扫描学习。本书是专为高等职业教育计算机、美术设计、电子商务专业的网站设计与网页制作课程的专业教材。也可以作为高级网页制作者的培训教材。全国计算机信息高技术高级网页制作人员考试网页制作技能强化综合练习题8套。技能强化培训材料均为原创作品以上资源可从华信教育资源网()下载。同时附有微课视频,可在书内二维码扫描学习。本书是专为高等职业教育计算机、美术设计、电子商务专业的网站设计与网页制作课程的专业教材。也可以作为高级网页制作者的培训教材。技能强化培训材料均为原创作品以上资源可从华信教育资源网()下载。同时附有微课视频,可在书内二维码扫描学习。本书是专为高等职业教育计算机、美术设计、电子商务专业的网站设计与网页制作课程的专业教材。也可以作为高级网页制作者的培训教材。技能强化培训材料均为原创作品以上资源可从华信教育资源网()下载。同时附有微课视频,可在书内二维码扫描学习。本书是专为高等职业教育计算机、美术设计、电子商务专业的网站设计与网页制作课程的专业教材。也可以作为高级网页制作者的培训教材。@网站专为高等职业教育计算机、艺术设计、电子商务专业开设的设计与网页制作课程。也可以作为高级网页制作者的培训教材。@网站专为高等职业教育计算机、艺术设计、电子商务专业开设的设计与网页制作课程。也可以作为高级网页制作者的培训教材。

·点击进入下载地址

这本书有电子版。如果无法下载,请加入我们的Q群:972703811联系获取。

· 围观:下载的电子书丢失或不完整怎么办?

·干货:哪里可以下载电子书资源?

尖端: 查看全部

抓取网页生成电子书(

的“我的E站”设计制作)

本书采用的“我的E站”项目的设计与制作,为读者全面展示了网站设计与网页制作的基础知识,让没有网页制作基础知识的读者也能轻松上手。发展和产生自己的想法。网站 的。本书遵循网站开发的大致流程,主要介绍网站前期规划;网站结构创建;网页界面设计;简单的图像处理;图像和文本、列表、表格、模板和表单 DIV+CSS 标准布局;CSS 样式应用程序;多媒体和 Flash 应用程序;JavaScript 基础应用;网站创建和上传;网站 兼容性测试;文书写作;响应式设计等。本书免费提供书中所有资料。此外,全国计算机信息高技术考试高级网页制作人员网页制作技能强化综合练习题8套。技能强化培训材料均为原创作品以上资源可从华信教育资源网()下载。同时附有微课视频,可在书内二维码扫描学习。本书是专为高等职业教育计算机、美术设计、电子商务专业的网站设计与网页制作课程的专业教材。也可以作为高级网页制作者的培训教材。全国计算机信息高技术高级网页制作人员考试网页制作技能强化综合练习题8套。技能强化培训材料均为原创作品以上资源可从华信教育资源网()下载。同时附有微课视频,可在书内二维码扫描学习。本书是专为高等职业教育计算机、美术设计、电子商务专业的网站设计与网页制作课程的专业教材。也可以作为高级网页制作者的培训教材。全国计算机信息高技术高级网页制作人员考试网页制作技能强化综合练习题8套。技能强化培训材料均为原创作品以上资源可从华信教育资源网()下载。同时附有微课视频,可在书内二维码扫描学习。本书是专为高等职业教育计算机、美术设计、电子商务专业的网站设计与网页制作课程的专业教材。也可以作为高级网页制作者的培训教材。技能强化培训材料均为原创作品以上资源可从华信教育资源网()下载。同时附有微课视频,可在书内二维码扫描学习。本书是专为高等职业教育计算机、美术设计、电子商务专业的网站设计与网页制作课程的专业教材。也可以作为高级网页制作者的培训教材。技能强化培训材料均为原创作品以上资源可从华信教育资源网()下载。同时附有微课视频,可在书内二维码扫描学习。本书是专为高等职业教育计算机、美术设计、电子商务专业的网站设计与网页制作课程的专业教材。也可以作为高级网页制作者的培训教材。@网站专为高等职业教育计算机、艺术设计、电子商务专业开设的设计与网页制作课程。也可以作为高级网页制作者的培训教材。@网站专为高等职业教育计算机、艺术设计、电子商务专业开设的设计与网页制作课程。也可以作为高级网页制作者的培训教材。

·点击进入下载地址

这本书有电子版。如果无法下载,请加入我们的Q群:972703811联系获取。

· 围观:下载的电子书丢失或不完整怎么办?

·干货:哪里可以下载电子书资源?

尖端:

抓取网页生成电子书( Android移动开发基础案例教程-爬取电子书)

网站优化 • 优采云 发表了文章 • 0 个评论 • 104 次浏览 • 2022-04-11 03:30

Android移动开发基础案例教程-爬取电子书)

前言

为了省钱,小编找了一本电子书网站,“学霸”,小编搜了一下,找到了“学霸清华”

但不是唯一的,还有“学术北京师范大学珠海分校”,应该是学校后缀的。

一旦我们注册了一个帐户,我们就可以开始抓取我们想要的电子书了。

这两个网站结构相似。

爬取分析

编辑选择这个url作为爬虫

我们以爬取《Android移动开发基础案例教程》为例

打开开发者工具,翻了几页发现是动态加载的,url如下

我们看到url中有一个参数t,说明在请求的时候需要构造这个参数t,并拼接url来请求它

视觉上可能是时间戳,我们可以使用 time.time() 来生成时间戳

与参数t相比,python代码生成小数,长度不同。乘以 1000 然后使用 int() 函数使其长度与参数 t 相同,但 int() 直接丢弃小数点。是的,我们不知道t是否取整,所以为了保证一次性请求成功,编辑器直接执行生成参数t的js代码,生成对应的参数t,即绝对正确。

js生成时间戳的代码如下

在python中使用execjs执行js代码

这样,我们爬取请求的必要参数就解决了。

其余的可以根据爬虫逻辑直接写。

注意pdf只能浏览前十页。如果你想全部浏览,你需要登录并在请求头中放一个cookie。

pdf合并

爬下来后是pdf文件,文件名以页码命名,我们需要全部合并成pdf,代码如下:

综合结果如下:

合并完成后,我们就有了电子书。

吃饱喝足的感觉真好,这样我就可以省钱买皮了。 查看全部

抓取网页生成电子书(

Android移动开发基础案例教程-爬取电子书)

前言

为了省钱,小编找了一本电子书网站,“学霸”,小编搜了一下,找到了“学霸清华”

但不是唯一的,还有“学术北京师范大学珠海分校”,应该是学校后缀的。

一旦我们注册了一个帐户,我们就可以开始抓取我们想要的电子书了。

这两个网站结构相似。

爬取分析

编辑选择这个url作为爬虫

我们以爬取《Android移动开发基础案例教程》为例

打开开发者工具,翻了几页发现是动态加载的,url如下

我们看到url中有一个参数t,说明在请求的时候需要构造这个参数t,并拼接url来请求它

视觉上可能是时间戳,我们可以使用 time.time() 来生成时间戳

与参数t相比,python代码生成小数,长度不同。乘以 1000 然后使用 int() 函数使其长度与参数 t 相同,但 int() 直接丢弃小数点。是的,我们不知道t是否取整,所以为了保证一次性请求成功,编辑器直接执行生成参数t的js代码,生成对应的参数t,即绝对正确。

js生成时间戳的代码如下

在python中使用execjs执行js代码

这样,我们爬取请求的必要参数就解决了。

其余的可以根据爬虫逻辑直接写。

注意pdf只能浏览前十页。如果你想全部浏览,你需要登录并在请求头中放一个cookie。

pdf合并

爬下来后是pdf文件,文件名以页码命名,我们需要全部合并成pdf,代码如下:

综合结果如下:

合并完成后,我们就有了电子书。

吃饱喝足的感觉真好,这样我就可以省钱买皮了。

抓取网页生成电子书(【,】)

网站优化 • 优采云 发表了文章 • 0 个评论 • 150 次浏览 • 2022-04-05 03:11

网络视频采集工具正式版通过/fileview_2523891.html上传到126下载网免费下载。

[color=#008000]================================= === ====[/color][color=#f00000]重要提示:【网络视频爬虫】已更新至最新稳定版! [/color][color=#f00000]功能更稳定更强大!永远免费!其他版本已过期,请下载最新版本↓↓[/color][color=#008000]最新稳定版可以高速下载:[ /color][ /b][b][color=#0000f0]点击这里立即下载[/color] [color=#008000]电信用户高速下载:[/color][color=#0000f0]电信下载一个[/color][color=#0000f0]电信下载2[/color] [color=#008000]高速下载来自其他网络:[/color][color=#0000f0]高速下载一个[/color][color=#0000f0]高速下载二[/color] [color=#008000]==== ==== ================================[/color] 查看全部

抓取网页生成电子书(【,】)

网络视频采集工具正式版通过/fileview_2523891.html上传到126下载网免费下载。

[color=#008000]================================= === ====[/color][color=#f00000]重要提示:【网络视频爬虫】已更新至最新稳定版! [/color][color=#f00000]功能更稳定更强大!永远免费!其他版本已过期,请下载最新版本↓↓[/color][color=#008000]最新稳定版可以高速下载:[ /color][ /b][b][color=#0000f0]点击这里立即下载[/color] [color=#008000]电信用户高速下载:[/color][color=#0000f0]电信下载一个[/color][color=#0000f0]电信下载2[/color] [color=#008000]高速下载来自其他网络:[/color][color=#0000f0]高速下载一个[/color][color=#0000f0]高速下载二[/color] [color=#008000]==== ==== ================================[/color]

抓取网页生成电子书( 全篇的实现思路分析网页学会使用BeautifulSoup库爬取并导出参考资料)

网站优化 • 优采云 发表了文章 • 0 个评论 • 95 次浏览 • 2022-03-31 16:00

全篇的实现思路分析网页学会使用BeautifulSoup库爬取并导出参考资料)

Python 抓取网页并将其转换为 PDF 文件

爬行动物的成因

虽然可以查阅官方文件或手册,但如果是纸质的,是不是更容易阅读和记忆。如果是简单的复制粘贴,不知道什么时候能完成。于是我开始考虑爬下安卓官方手册。

整篇文章的实现思路

分析网页,学习使用BeautifulSoup库爬取导出

参考:

* 将廖雪峰的教程转换成PDF电子书

* 请求文件

* 美丽的汤文档

配置

Ubuntu下使用Pycharm成功运行

要转换PDF,您需要下载wkhtmltopdf

具体流程

网页分析

如下图的一个网页,要做的就是获取网页的body和title,以及左侧导航栏的所有url

接下来的工作是找到这些标签......

关于请求的使用

详细参考文档,这里只是简单的使用Requests获取html并使用代理翻墙(网站不能直接访问,需要VPN)

proxies={

"http":"http://vpn的IP:port",

"https":"https://vpn的IP:port",

}

response=requests.get(url,proxies=proxies)

美汤的使用

参考资料中有一个 Beautiful Soup 文档。看完可以知道有两件事:一是找标签,二是修改标签。

这篇文章需要做的是:

1. 获取标题和所有url,这涉及到查找标签

#对标签进行判断,一个标签含有href而不含有description,则返回true

#而我希望获取的是含有href属性而不含有description属性的<a>标签,(且只有a标签含有href)

def has_href_but_no_des(tag):

return tag.has_attr('href') and not tag.has_attr('description')

#网页分析,获取网址和标题

def parse_url_to_html(url):

response=requests.get(url,proxies=proxies)

soup=BeautifulSoup(response.content,"html.parser")

s=[]#获取所有的网址

title=[]#获取对应的标题

tag=soup.find(id="nav")#获取第一个id为"nav"的标签,这个里面包含了网址和标题

for i in tag.find_all(has_href_but_no_des):

s.append(i['href'])

title.append(i.text)

#获取的只是标签集,需要加html前缀

htmls = ""

with open("android_training_3.html",'a') as f:

f.write(htmls)

解析上面得到的URL,获取文本,取出图片保存在本地;它涉及查找标签和修改属性

#网页操作,获取正文及图片

def get_htmls(urls,title):

for i in range(len(urls)):

response=requests.get(urls[i],proxies=proxies)

soup=BeautifulSoup(response.content,"html.parser")

htmls=""+str(i)+"."+title[i]+""

tag=soup.find(class_='jd-descr')

#为image添加相对路径,并下载图片

for img in tag.find_all('img'):

im = requests.get(img['src'], proxies=proxies)

filename = os.path.split(img['src'])[1]

with open('image/' + filename, 'wb') as f:

f.write(im.content)

img['src']='image/'+filename

htmls=htmls+str(tag)