抓取网页数据php

抓取网页数据php(蜘蛛抓取第一步爬行和抓取爬行到你的网站网页网页)

网站优化 • 优采云 发表了文章 • 0 个评论 • 55 次浏览 • 2022-01-01 01:20

蜘蛛爬行的第一步是爬行爬行

<p>爬到您的 网站 页面以找到合适的资源。蜘蛛有一个特点,就是它们的运动轨迹通常都围绕着蜘蛛丝,而我们之所以命名为搜索引擎机器人蜘蛛,其实就是因为这个特点。当蜘蛛来到你的网站时,它会跟随你网站中的链接(蜘蛛丝)继续爬行,那么如何让蜘蛛更好的在你的网站中爬行就成了我们的首要任务。抓取您的网页。引导蜘蛛爬行这只是一个开始,一个好的开始意味着你会有一个高起点。通过自身的内链设计,网站中没有死角,蜘蛛可以轻松到达网站中的每一页,让蜘蛛在做第二步的工作——爬行时,将事半功倍。在这个爬取过程中,我们需要注意的是精简网站的结构,去掉不必要的和不必要的冗余代码,因为这些都会影响蜘蛛爬取网页的效率和效率。影响。还有一点需要注意的是,我们不建议将FLASH放在网站,因为蜘蛛不容易抓取FLASH,过多的FLASH会导致蜘蛛放弃抓取你的网站页面。 查看全部

抓取网页数据php(蜘蛛抓取第一步爬行和抓取爬行到你的网站网页网页)

蜘蛛爬行的第一步是爬行爬行

<p>爬到您的 网站 页面以找到合适的资源。蜘蛛有一个特点,就是它们的运动轨迹通常都围绕着蜘蛛丝,而我们之所以命名为搜索引擎机器人蜘蛛,其实就是因为这个特点。当蜘蛛来到你的网站时,它会跟随你网站中的链接(蜘蛛丝)继续爬行,那么如何让蜘蛛更好的在你的网站中爬行就成了我们的首要任务。抓取您的网页。引导蜘蛛爬行这只是一个开始,一个好的开始意味着你会有一个高起点。通过自身的内链设计,网站中没有死角,蜘蛛可以轻松到达网站中的每一页,让蜘蛛在做第二步的工作——爬行时,将事半功倍。在这个爬取过程中,我们需要注意的是精简网站的结构,去掉不必要的和不必要的冗余代码,因为这些都会影响蜘蛛爬取网页的效率和效率。影响。还有一点需要注意的是,我们不建议将FLASH放在网站,因为蜘蛛不容易抓取FLASH,过多的FLASH会导致蜘蛛放弃抓取你的网站页面。

抓取网页数据php(三种数据抓取的方法(bs4)*利用之前构建的下载网页函数)

网站优化 • 优采云 发表了文章 • 0 个评论 • 77 次浏览 • 2022-01-01 01:18

数据采集的三种方法

正则表达式(重新库)

BeautifulSoup (bs4)

lxml

*利用之前构建的下载页面函数获取目标网页的html,我们使用

https://guojiadiqu.bmcx.com/AFG__guojiayudiqu/为例,获取html。

from get_html import download

url = 'https://guojiadiqu.bmcx.com/AF ... 39%3B

page_content = download(url)

*假设我们需要抓取这个网页中的国家名称和简介,我们依次使用这三种数据抓取方式来实现数据抓取。

1.正则表达式

from get_html import download

import re

url = 'https://guojiadiqu.bmcx.com/AF ... 39%3B

page_content = download(url)

country = re.findall('class="h2dabiaoti">(.*?)', page_content) #注意返回的是list

survey_data = re.findall('(.*?)', page_content)

survey_info_list = re.findall('<p> (.*?)', survey_data[0])

survey_info = ''.join(survey_info_list)

print(country[0],survey_info)</p>

2.BeautifulSoup (bs4)

from get_html import download

from bs4 import BeautifulSoup

url = 'https://guojiadiqu.bmcx.com/AF ... 39%3B

html = download(url)

#创建 beautifulsoup 对象

soup = BeautifulSoup(html,"html.parser")

#搜索

country = soup.find(attrs={'class':'h2dabiaoti'}).text

survey_info = soup.find(attrs={'id':'wzneirong'}).text

print(country,survey_info)

3.lxml

from get_html import download

from lxml import etree #解析树

url = 'https://guojiadiqu.bmcx.com/AF ... 39%3B

page_content = download(url)

selector = etree.HTML(page_content)#可进行xpath解析

country_select = selector.xpath('//*[@id="main_content"]/h2') #返回列表

for country in country_select:

print(country.text)

survey_select = selector.xpath('//*[@id="wzneirong"]/p')

for survey_content in survey_select:

print(survey_content.text,end='')

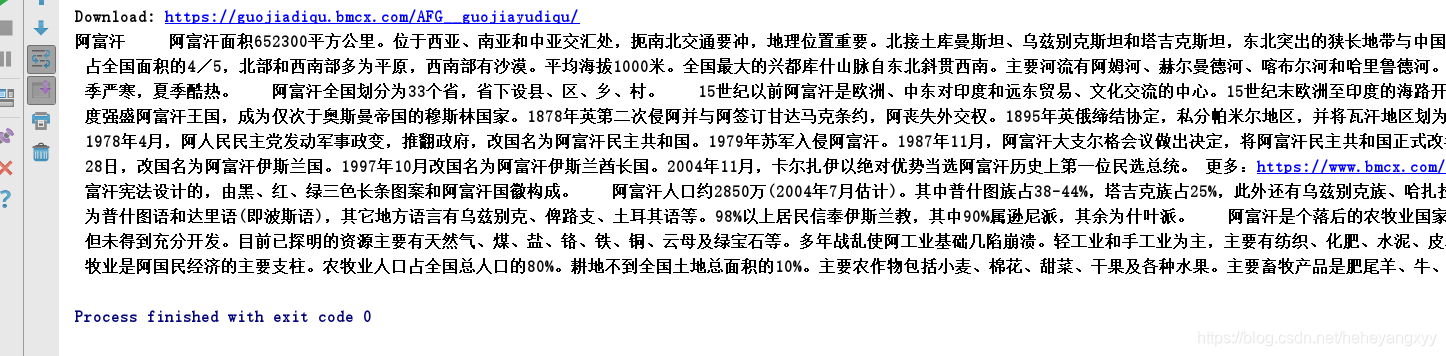

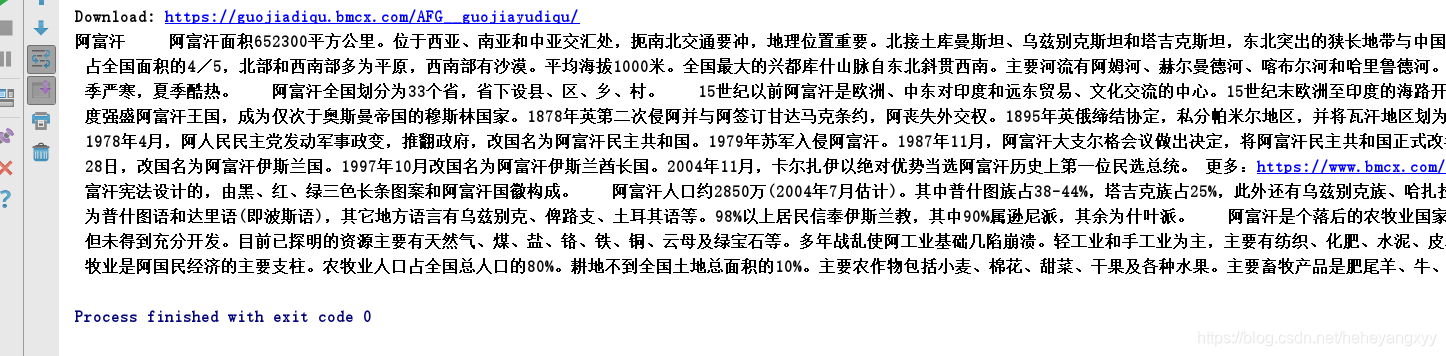

运行结果:

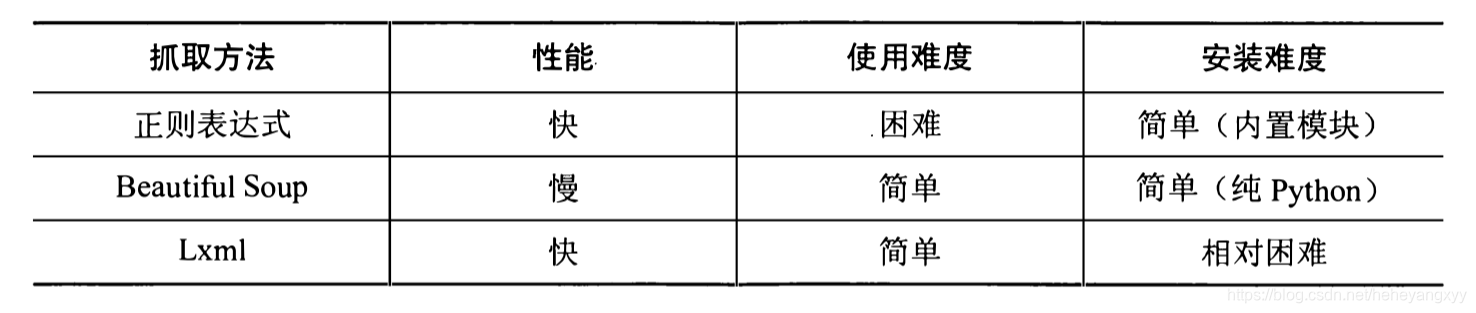

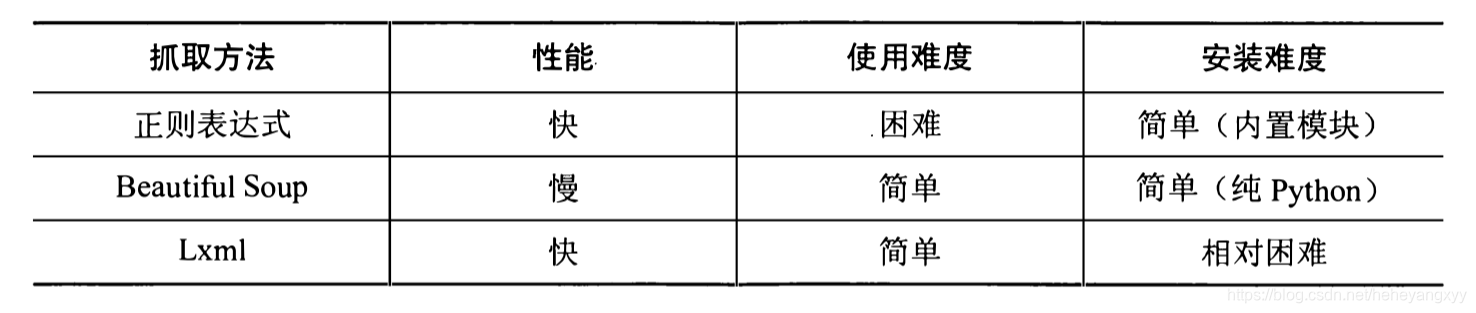

最后引用《Writing Web Crawlers in Python》中三种方法的性能对比,如下图:

仅供参考。 查看全部

抓取网页数据php(三种数据抓取的方法(bs4)*利用之前构建的下载网页函数)

数据采集的三种方法

正则表达式(重新库)

BeautifulSoup (bs4)

lxml

*利用之前构建的下载页面函数获取目标网页的html,我们使用

https://guojiadiqu.bmcx.com/AFG__guojiayudiqu/为例,获取html。

from get_html import download

url = 'https://guojiadiqu.bmcx.com/AF ... 39%3B

page_content = download(url)

*假设我们需要抓取这个网页中的国家名称和简介,我们依次使用这三种数据抓取方式来实现数据抓取。

1.正则表达式

from get_html import download

import re

url = 'https://guojiadiqu.bmcx.com/AF ... 39%3B

page_content = download(url)

country = re.findall('class="h2dabiaoti">(.*?)', page_content) #注意返回的是list

survey_data = re.findall('(.*?)', page_content)

survey_info_list = re.findall('<p> (.*?)', survey_data[0])

survey_info = ''.join(survey_info_list)

print(country[0],survey_info)</p>

2.BeautifulSoup (bs4)

from get_html import download

from bs4 import BeautifulSoup

url = 'https://guojiadiqu.bmcx.com/AF ... 39%3B

html = download(url)

#创建 beautifulsoup 对象

soup = BeautifulSoup(html,"html.parser")

#搜索

country = soup.find(attrs={'class':'h2dabiaoti'}).text

survey_info = soup.find(attrs={'id':'wzneirong'}).text

print(country,survey_info)

3.lxml

from get_html import download

from lxml import etree #解析树

url = 'https://guojiadiqu.bmcx.com/AF ... 39%3B

page_content = download(url)

selector = etree.HTML(page_content)#可进行xpath解析

country_select = selector.xpath('//*[@id="main_content"]/h2') #返回列表

for country in country_select:

print(country.text)

survey_select = selector.xpath('//*[@id="wzneirong"]/p')

for survey_content in survey_select:

print(survey_content.text,end='')

运行结果:

最后引用《Writing Web Crawlers in Python》中三种方法的性能对比,如下图:

仅供参考。

抓取网页数据php(20+网页采集工具—5分钟提取线上数据网页爬虫)

网站优化 • 优采云 发表了文章 • 0 个评论 • 150 次浏览 • 2021-12-22 05:11

请查看原文文章:20+网页采集工具-5分钟提取在线数据

网络爬虫(又称数据抽取、数据采集、数据爬虫)现在在很多领域都有广泛的应用。在网络爬虫工具出现之前,它对于没有编程技能的普通人来说是一个神奇的词,它的高进入门槛让人们远离了大数据的大门。而网络爬虫是一种自动数据抓取技术,通过自动爬取数据减少了手动复制粘贴的繁琐步骤,缩短了我们与数据的距离。

使用网络爬虫有什么好处?

它消除了重复复制和粘贴工作的需要。

它将提取的数据转换为结构良好的格式,包括但不限于 Excel、HTML 和 CSV。

它可以帮助您节省时间和金钱,而无需聘请专业数据分析师。

这是营销人员、卖家、记者、YouTube 用户、研究人员和许多其他缺乏技术技能的人的秘诀。

我列出了 20 个最好的网络爬虫工具供您参考。欢迎充分利用它!

八爪鱼

Octoparse 是一个强大的网站 搜索引擎,可以在网站 上提取几乎所有你需要的数据。您可以使用 Octoparse 爬取 网站 的各种功能。它有2种操作模式——任务模板模式和高级模式——非程序员也能快速上手。友好的点击界面可以引导您完成整个提取过程。因此,您可以轻松地将网站的内容提取出来,并在短时间内将其保存为EXCEL、TXT、HTML或数据库等结构化格式。

此外,它还提供计划的云提取,让您实时提取动态数据并在 网站 更新中保持跟踪记录。您还可以通过使用内置的 Regex 和 XPath 配置来准确定位元素,以提取复杂的结构 网站。您不再需要担心 IP 阻塞。Octoparse 提供了一个 IP 代理服务器,它会自动执行 IP,不会被攻击性的 网站 发现。总之,Octoparse 应该能够满足用户最基本或高级的爬虫需求,无需任何编码技能。

Cyotek 网络复制

WebCopy 是对网络爬虫的非常形象的描述。这是一个免费的网站 搜索引擎,允许您将网站 的部分或全部本地复制到您的硬盘以供离线参考。您可以更改其设置以告诉机器人您想如何爬行。此外,您还可以配置域别名、用户代理字符串、默认文档等。

但是,WebCopy 不包括虚拟 DOM 或任何形式的 JavaScript 解析。如果 网站 大量使用 JavaScript 进行操作,WebCopy 可能无法制作真正的副本。由于大量使用 JavaScript,动态 网站 布局可能无法正确处理。

HTTrack

作为网站搜索器的免费软件,HTTrack提供将网站整个下载到您的PC的功能。有适用于Windows、Linux、Sun Solaris等Unix系统的版本,覆盖大部分用户。有趣的是,HTTrack 可以镜像一个站点,也可以将多个站点镜像在一起(使用共享链接)。您可以在“设置”下确定下载网页时同时打开的连接数。您可以从其镜像的 网站 中获取照片、文件和 HTML 代码,并恢复中断的下载。

此外,HTTrack 中提供了代理支持以最大限度地提高速度。

HTTrack 既可以作为命令行程序使用,也可以通过shell 供私有(捕获)或专业(在线网络镜像)使用。适用于具有高级编程能力的用户。

左转

Getleft 是一款免费且易于使用的 网站 爬虫工具。它允许您下载整个 网站 或任何单个网页。启动Getleft后,输入网址,选择要下载的文件,即可开始下载。随着它的进行,它将更改本地浏览的所有链接。此外,它还提供多语言支持。现在,Getleft 支持 14 种语言!然而,它只提供有限的 Ftp 支持,它会下载文件,但不会递归。

总的来说,Getleft 应该能满足用户基本的爬虫需求,不需要更复杂的战术技巧。

刮刀

Scraper 是一个 Chrome 扩展,数据提取能力有限,但对在线研究很有帮助。它还允许将数据导出到 Google 电子表格。该工具适合初学者和专家。您可以使用 OAuth 轻松地将数据复制到剪贴板或将其存储在电子表格中。Scraper 可以自动生成 XPath 来定义要爬取的 URL。它没有提供包罗万象的爬虫服务,但大多数人仍然不需要处理杂乱的配置。

OutWit 中心

OutWit Hub 是 Firefox 的附加组件,具有许多数据提取功能,可简化您的网络搜索。网络爬虫工具可以浏览页面并将提取的信息以适当的格式存储。

OutWit Hub 提供了一个单一的界面,可以根据需要捕获少量或大量的数据。OutWit Hub 允许您从浏览器本身抓取任何网页。它甚至可以创建自动代理来提取数据。

它是最简单的网页抓取工具之一,免费提供,让您无需编写一行代码即可方便地提取网页数据。

分析中心

Parsehub 是一款优秀的网络爬虫,支持使用 AJAX 技术、JavaScript、Cookies 等从 网站 采集数据,其机器学习技术可以读取、分析 Web 文档,然后将其转换为相关数据。

Parsehub 的桌面应用程序支持 Windows、Mac OS X 和 Linux 系统。您甚至可以使用浏览器中内置的 Web 应用程序。

作为免费软件,您最多可以在 Parsehub 中构建五个公共项目。付费订阅计划允许您创建至少 20 个用于爬取 网站 的私人项目。

视觉刮板

VisualScraper 是另一个很棒的免费和非编码网络爬虫程序,具有简单的点击界面。您可以从多个网页获取实时数据,并将提取的数据导出为 CSV、XML、JSON 或 SQL 文件。除了 SaaS,VisualScraper 还提供网络抓取服务,例如数据交付服务和创建软件提取器服务。

Visual Scraper 允许用户安排项目在特定时间运行,或每分钟/天/周/月/年重复该序列。用户可以使用它来频繁地获取新闻、更新、论坛。

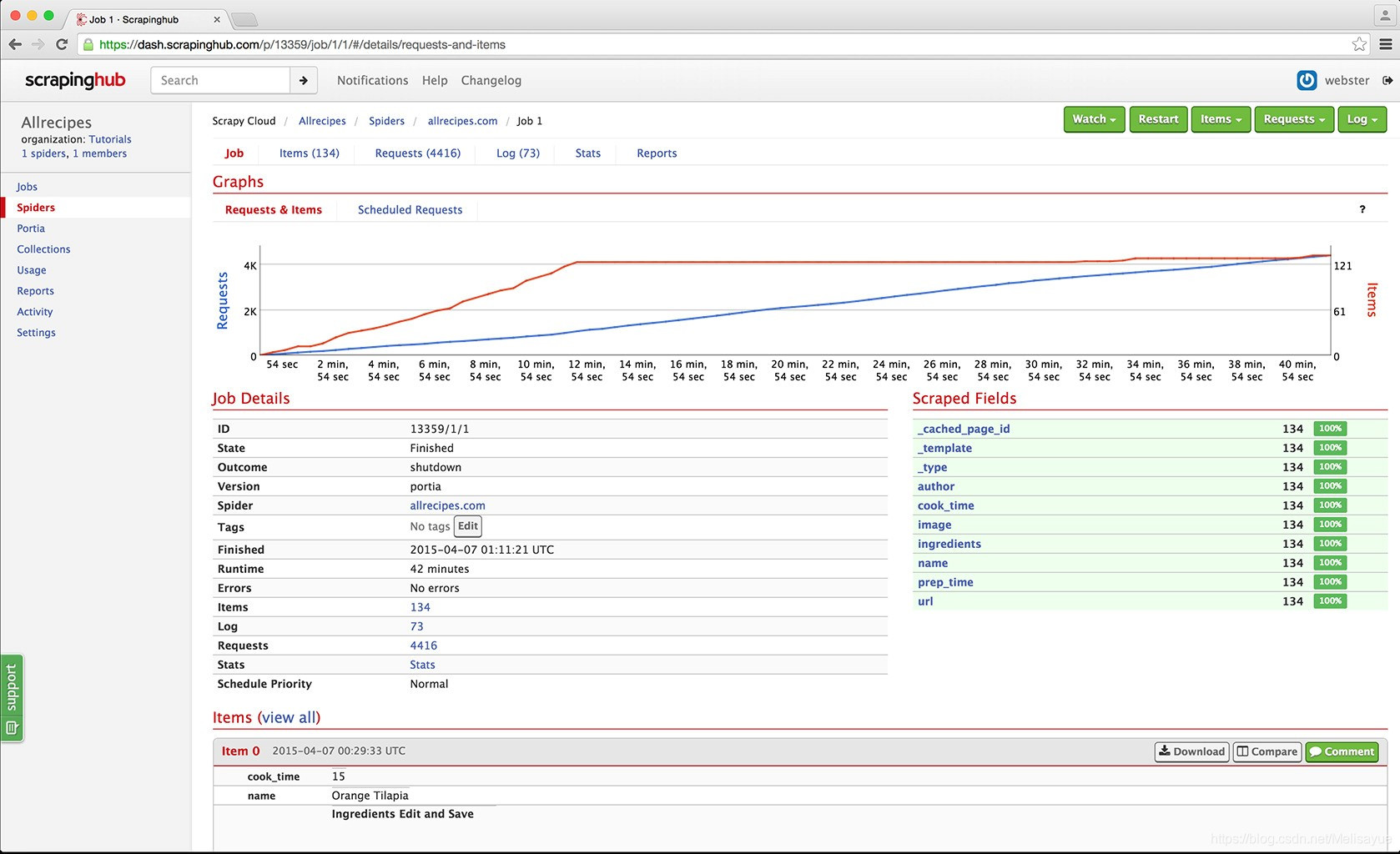

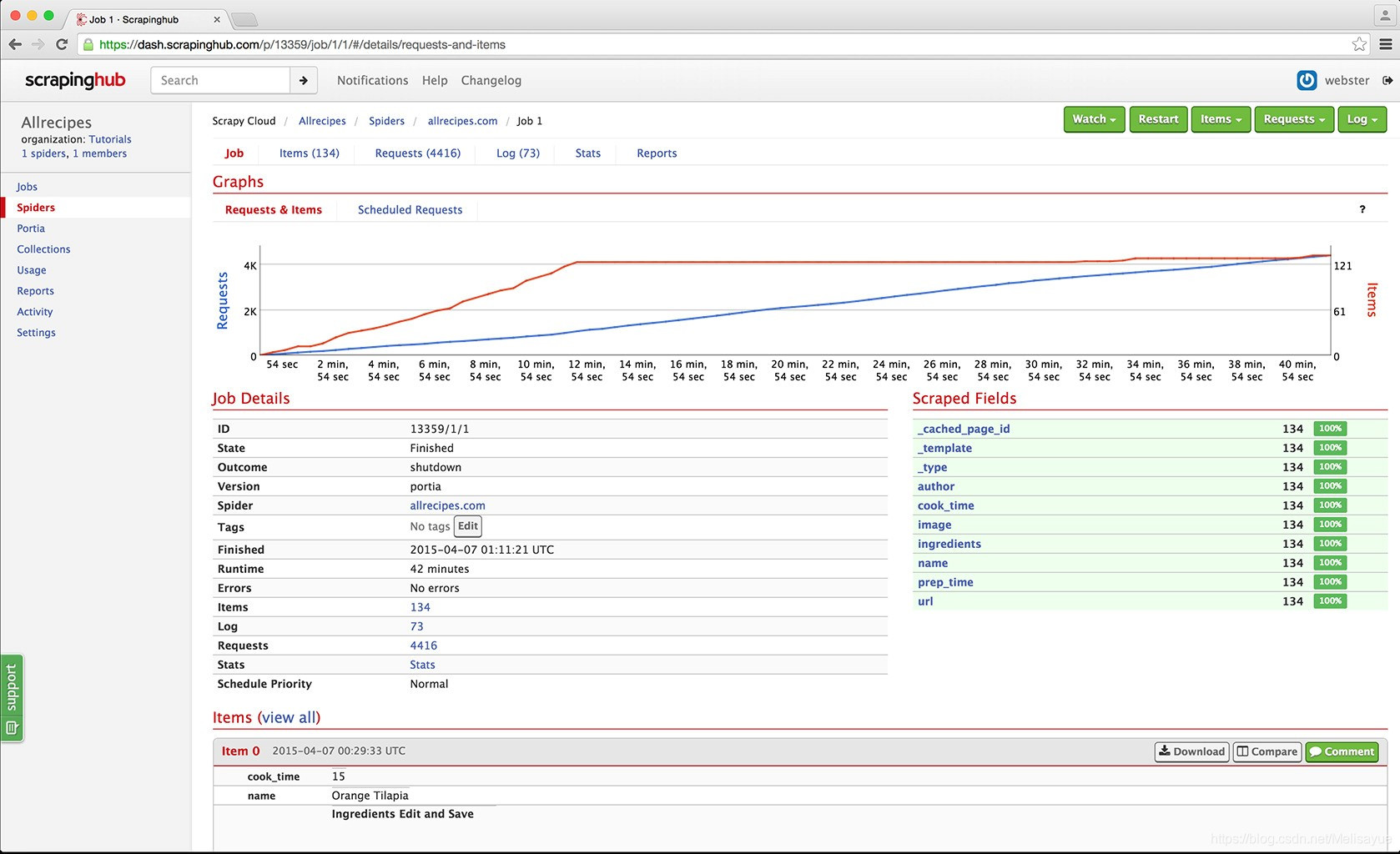

抓取中心

Scrapinghub 是一种基于云的数据提取工具,可以帮助成千上万的开发人员获取有价值的数据。其开源的可视化爬取工具让用户无需任何编程知识即可爬取网站。

Scrapinghub 使用 Crawlera,这是一种智能代理微调器,支持绕过机器人对抗措施以轻松抓取大型或受机器人保护的站点。它允许用户通过简单的 HTTP API 从多个 IP 和位置进行爬取,无需代理管理。

Scrapinghub 将整个网页转换为结构化内容。如果其爬虫构建器无法满足您的要求,其专家团队将为您提供帮助。

德喜

作为一款基于浏览器的爬虫,Dexi.io 允许您从任何基于浏览器的网站 中抓取数据,并提供了三种机器人来创建抓取任务——提取器、爬虫和管道。这个免费软件为您的网络抓取提供了一个匿名的网络代理服务器。您提取的数据将在数据存档前在 Dexi.io 的服务器上托管两周,或者您可以将提取的数据直接导出为 JSON 或 CSV 文件。提供付费服务,满足您获取实时数据的需求。

网管网

Webhose.io 使用户能够从来自世界各地的各种干净格式的在线资源中捕获实时数据。使用此网络爬虫,您可以使用覆盖多个来源的多个过滤器来爬取数据并进一步提取多种不同语言的关键字。

您可以将捕获的数据保存为 XML、JSON 和 RSS 格式。并允许用户从其档案中访问历史数据。此外,webhose.io 的爬取数据结果支持多达 80 种语言。用户可以轻松索引和搜索 Webhose.io 抓取的结构化数据。

总体来说,Webhose.io可以满足用户的基本爬取需求。

进口。io

用户可以通过简单地从特定网页导入数据并将数据导出为 CSV 来形成自己的数据集。

无需编写任何代码,您可以在几分钟内轻松抓取数千个网页,并且可以根据需要构建 1,000 多个 API。公共API提供了强大而灵活的功能,可以通过编程控制Import.io,实现数据的自动访问,而Import.io只需点击几下或网站中,即可将网页数据集成到自己的应用中,从而让爬取更轻松.

为了更好地满足用户的爬取需求,它还提供了免费的Windows、Mac OS X和Linux应用程序,用于构建数据提取器和爬虫、下载数据和与在线帐户同步。此外,用户可以每周、每天或每小时安排抓取任务。

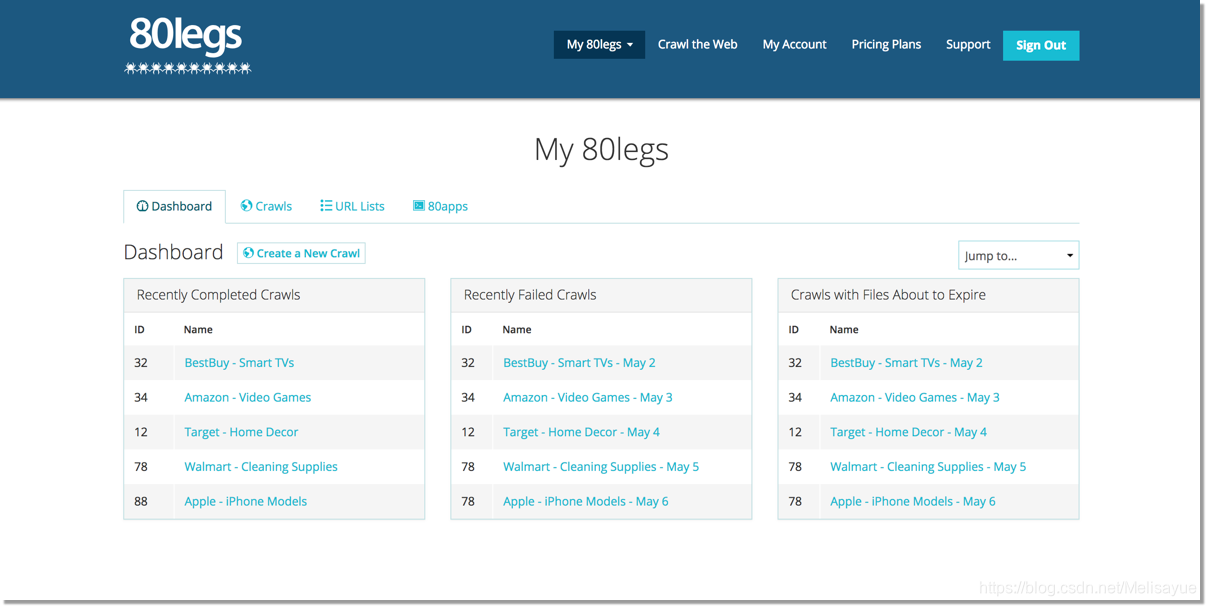

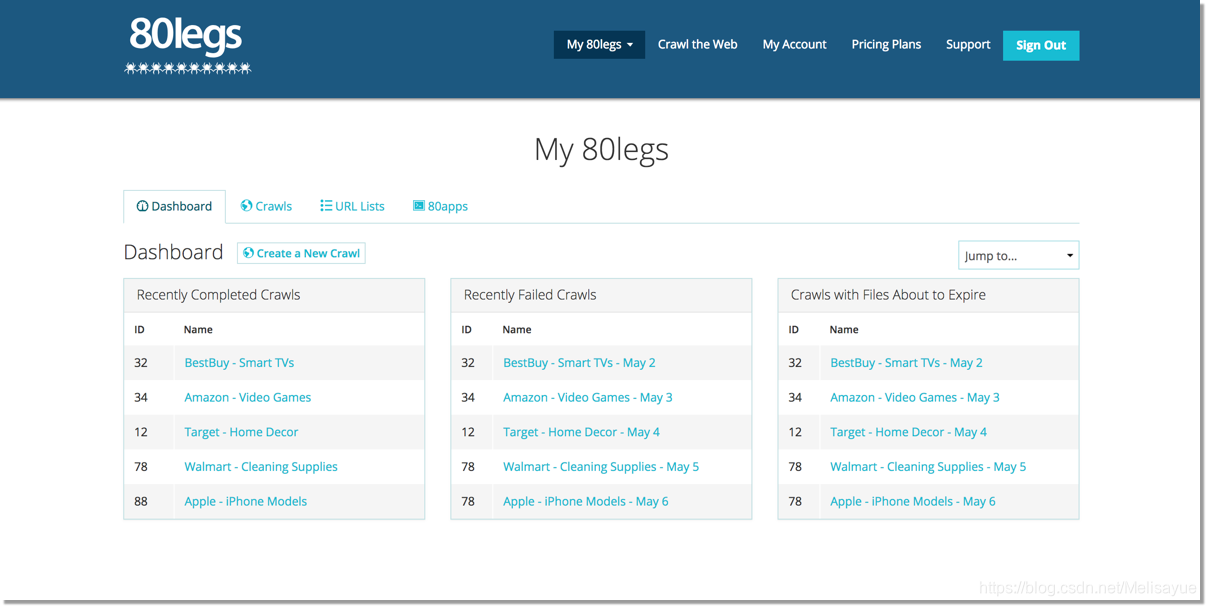

80腿

80legs 是一款功能强大的网络爬虫工具,可根据自定义需求进行配置。它支持获取大量数据,并且可以立即下载提取的数据。80legs提供高性能的网络爬虫,可以快速运行,几秒内获取所需数据

Spinn3r

Spinn3r 允许您从博客、新闻和社交媒体 网站 以及 RSS 和 ATOM 提要中获取所有数据。Spinn3r 与 Firehouse API 一起分发,它管理着 95% 的索引工作。它提供了先进的垃圾邮件保护功能,可以消除垃圾邮件和不恰当的语言使用,从而提高数据安全性。

Spinn3r 索引类似于 Google 的内容并将提取的数据保存在 JSON 文件中。网络爬虫会不断扫描网络并从多个来源寻找更新以获得实时出版物。它的管理控制台允许您控制爬行,而全文搜索允许对原创数据进行复杂查询。

内容抓取器

Content Grabber 是一款面向企业的网络爬虫软件。它允许您创建一个独立的网络爬虫代理。它可以从几乎所有网站 中提取内容,并以您选择的格式将其保存为结构化数据,包括 Excel 报告、XML、CSV 和大多数数据库。

因为它为需要的人提供了许多强大的脚本编辑和调试接口,所以更适合具有高级编程技能的人。允许用户使用 C# 或 VB.NET 调试或编写脚本来控制抓取过程的编程。例如,Content Grabber 可以与 Visual Studio 2013 集成,根据用户的特定需求,对高级、机智的自定义爬虫执行最强大的脚本编辑、调试和单元测试。

氦气刮刀

Helium Scraper 是一款可视化的网络数据爬取软件,当元素之间的相关性较小时效果很好。它是非编码和不可配置的。用户可以根据各种爬取需求访问在线模板。

基本上可以满足用户群的爬取需求。

路径

UiPath 是一款用于免费网络爬虫的机器人流程自动化软件。它可以从大多数第三方应用程序中自动抓取 Web 和桌面数据。如果在 Windows 上运行它,则可以安装自动化流程自动化软件。Uipath 可以跨多个网页以表格格式提取数据。

Uipath 提供了用于进一步爬行的内置工具。这种方法在处理复杂的 UI 时非常有效。截屏工具可以处理单个文本元素、文本组和文本块,例如表格格式的数据提取。

此外,无需编程即可创建智能 Web 代理,但您的内部 .NET 黑客将完全控制数据。

抓取.it

Scrape.it 是一个 node.js 网页抓取软件。这是一个基于云的数据提取工具。它是为具有高级编程技能的人设计的,因为它提供了公共和私有包来发现、重用、更新和与全球数百万开发人员共享代码。其强大的集成将帮助您根据需要构建自定义搜索引擎。

网络哈维

WebHarvy 是一种点击式网页抓取软件。它是为非程序员设计的。WebHarvy 可以自动抓取 网站 中的文本、图像、URL 和电子邮件,并将抓取的内容以各种格式保存。它还提供了内置的调度器和代理支持,可以进行匿名爬网,防止网络爬虫软件被网络服务器拦截。您可以选择通过代理服务器或 VPN 访问目标。

用户可以以多种格式保存从网页中提取的数据。当前版本的 WebHarvy 网络爬虫工具允许您将爬取的数据导出为 XML、CSV、JSON 或 TSV 文件。用户还可以将捕获的数据导出到 SQL 数据库。

内涵

Connotate 是一个自动化的网络爬虫程序,专为企业级 Web 内容提取而设计。它需要企业级解决方案。业务用户无需任何编程即可在几分钟内轻松创建提取代理。用户只需单击一下即可轻松创建提取代理。 查看全部

抓取网页数据php(20+网页采集工具—5分钟提取线上数据网页爬虫)

请查看原文文章:20+网页采集工具-5分钟提取在线数据

网络爬虫(又称数据抽取、数据采集、数据爬虫)现在在很多领域都有广泛的应用。在网络爬虫工具出现之前,它对于没有编程技能的普通人来说是一个神奇的词,它的高进入门槛让人们远离了大数据的大门。而网络爬虫是一种自动数据抓取技术,通过自动爬取数据减少了手动复制粘贴的繁琐步骤,缩短了我们与数据的距离。

使用网络爬虫有什么好处?

它消除了重复复制和粘贴工作的需要。

它将提取的数据转换为结构良好的格式,包括但不限于 Excel、HTML 和 CSV。

它可以帮助您节省时间和金钱,而无需聘请专业数据分析师。

这是营销人员、卖家、记者、YouTube 用户、研究人员和许多其他缺乏技术技能的人的秘诀。

我列出了 20 个最好的网络爬虫工具供您参考。欢迎充分利用它!

八爪鱼

Octoparse 是一个强大的网站 搜索引擎,可以在网站 上提取几乎所有你需要的数据。您可以使用 Octoparse 爬取 网站 的各种功能。它有2种操作模式——任务模板模式和高级模式——非程序员也能快速上手。友好的点击界面可以引导您完成整个提取过程。因此,您可以轻松地将网站的内容提取出来,并在短时间内将其保存为EXCEL、TXT、HTML或数据库等结构化格式。

此外,它还提供计划的云提取,让您实时提取动态数据并在 网站 更新中保持跟踪记录。您还可以通过使用内置的 Regex 和 XPath 配置来准确定位元素,以提取复杂的结构 网站。您不再需要担心 IP 阻塞。Octoparse 提供了一个 IP 代理服务器,它会自动执行 IP,不会被攻击性的 网站 发现。总之,Octoparse 应该能够满足用户最基本或高级的爬虫需求,无需任何编码技能。

Cyotek 网络复制

WebCopy 是对网络爬虫的非常形象的描述。这是一个免费的网站 搜索引擎,允许您将网站 的部分或全部本地复制到您的硬盘以供离线参考。您可以更改其设置以告诉机器人您想如何爬行。此外,您还可以配置域别名、用户代理字符串、默认文档等。

但是,WebCopy 不包括虚拟 DOM 或任何形式的 JavaScript 解析。如果 网站 大量使用 JavaScript 进行操作,WebCopy 可能无法制作真正的副本。由于大量使用 JavaScript,动态 网站 布局可能无法正确处理。

HTTrack

作为网站搜索器的免费软件,HTTrack提供将网站整个下载到您的PC的功能。有适用于Windows、Linux、Sun Solaris等Unix系统的版本,覆盖大部分用户。有趣的是,HTTrack 可以镜像一个站点,也可以将多个站点镜像在一起(使用共享链接)。您可以在“设置”下确定下载网页时同时打开的连接数。您可以从其镜像的 网站 中获取照片、文件和 HTML 代码,并恢复中断的下载。

此外,HTTrack 中提供了代理支持以最大限度地提高速度。

HTTrack 既可以作为命令行程序使用,也可以通过shell 供私有(捕获)或专业(在线网络镜像)使用。适用于具有高级编程能力的用户。

左转

Getleft 是一款免费且易于使用的 网站 爬虫工具。它允许您下载整个 网站 或任何单个网页。启动Getleft后,输入网址,选择要下载的文件,即可开始下载。随着它的进行,它将更改本地浏览的所有链接。此外,它还提供多语言支持。现在,Getleft 支持 14 种语言!然而,它只提供有限的 Ftp 支持,它会下载文件,但不会递归。

总的来说,Getleft 应该能满足用户基本的爬虫需求,不需要更复杂的战术技巧。

刮刀

Scraper 是一个 Chrome 扩展,数据提取能力有限,但对在线研究很有帮助。它还允许将数据导出到 Google 电子表格。该工具适合初学者和专家。您可以使用 OAuth 轻松地将数据复制到剪贴板或将其存储在电子表格中。Scraper 可以自动生成 XPath 来定义要爬取的 URL。它没有提供包罗万象的爬虫服务,但大多数人仍然不需要处理杂乱的配置。

OutWit 中心

OutWit Hub 是 Firefox 的附加组件,具有许多数据提取功能,可简化您的网络搜索。网络爬虫工具可以浏览页面并将提取的信息以适当的格式存储。

OutWit Hub 提供了一个单一的界面,可以根据需要捕获少量或大量的数据。OutWit Hub 允许您从浏览器本身抓取任何网页。它甚至可以创建自动代理来提取数据。

它是最简单的网页抓取工具之一,免费提供,让您无需编写一行代码即可方便地提取网页数据。

分析中心

Parsehub 是一款优秀的网络爬虫,支持使用 AJAX 技术、JavaScript、Cookies 等从 网站 采集数据,其机器学习技术可以读取、分析 Web 文档,然后将其转换为相关数据。

Parsehub 的桌面应用程序支持 Windows、Mac OS X 和 Linux 系统。您甚至可以使用浏览器中内置的 Web 应用程序。

作为免费软件,您最多可以在 Parsehub 中构建五个公共项目。付费订阅计划允许您创建至少 20 个用于爬取 网站 的私人项目。

视觉刮板

VisualScraper 是另一个很棒的免费和非编码网络爬虫程序,具有简单的点击界面。您可以从多个网页获取实时数据,并将提取的数据导出为 CSV、XML、JSON 或 SQL 文件。除了 SaaS,VisualScraper 还提供网络抓取服务,例如数据交付服务和创建软件提取器服务。

Visual Scraper 允许用户安排项目在特定时间运行,或每分钟/天/周/月/年重复该序列。用户可以使用它来频繁地获取新闻、更新、论坛。

抓取中心

Scrapinghub 是一种基于云的数据提取工具,可以帮助成千上万的开发人员获取有价值的数据。其开源的可视化爬取工具让用户无需任何编程知识即可爬取网站。

Scrapinghub 使用 Crawlera,这是一种智能代理微调器,支持绕过机器人对抗措施以轻松抓取大型或受机器人保护的站点。它允许用户通过简单的 HTTP API 从多个 IP 和位置进行爬取,无需代理管理。

Scrapinghub 将整个网页转换为结构化内容。如果其爬虫构建器无法满足您的要求,其专家团队将为您提供帮助。

德喜

作为一款基于浏览器的爬虫,Dexi.io 允许您从任何基于浏览器的网站 中抓取数据,并提供了三种机器人来创建抓取任务——提取器、爬虫和管道。这个免费软件为您的网络抓取提供了一个匿名的网络代理服务器。您提取的数据将在数据存档前在 Dexi.io 的服务器上托管两周,或者您可以将提取的数据直接导出为 JSON 或 CSV 文件。提供付费服务,满足您获取实时数据的需求。

网管网

Webhose.io 使用户能够从来自世界各地的各种干净格式的在线资源中捕获实时数据。使用此网络爬虫,您可以使用覆盖多个来源的多个过滤器来爬取数据并进一步提取多种不同语言的关键字。

您可以将捕获的数据保存为 XML、JSON 和 RSS 格式。并允许用户从其档案中访问历史数据。此外,webhose.io 的爬取数据结果支持多达 80 种语言。用户可以轻松索引和搜索 Webhose.io 抓取的结构化数据。

总体来说,Webhose.io可以满足用户的基本爬取需求。

进口。io

用户可以通过简单地从特定网页导入数据并将数据导出为 CSV 来形成自己的数据集。

无需编写任何代码,您可以在几分钟内轻松抓取数千个网页,并且可以根据需要构建 1,000 多个 API。公共API提供了强大而灵活的功能,可以通过编程控制Import.io,实现数据的自动访问,而Import.io只需点击几下或网站中,即可将网页数据集成到自己的应用中,从而让爬取更轻松.

为了更好地满足用户的爬取需求,它还提供了免费的Windows、Mac OS X和Linux应用程序,用于构建数据提取器和爬虫、下载数据和与在线帐户同步。此外,用户可以每周、每天或每小时安排抓取任务。

80腿

80legs 是一款功能强大的网络爬虫工具,可根据自定义需求进行配置。它支持获取大量数据,并且可以立即下载提取的数据。80legs提供高性能的网络爬虫,可以快速运行,几秒内获取所需数据

Spinn3r

Spinn3r 允许您从博客、新闻和社交媒体 网站 以及 RSS 和 ATOM 提要中获取所有数据。Spinn3r 与 Firehouse API 一起分发,它管理着 95% 的索引工作。它提供了先进的垃圾邮件保护功能,可以消除垃圾邮件和不恰当的语言使用,从而提高数据安全性。

Spinn3r 索引类似于 Google 的内容并将提取的数据保存在 JSON 文件中。网络爬虫会不断扫描网络并从多个来源寻找更新以获得实时出版物。它的管理控制台允许您控制爬行,而全文搜索允许对原创数据进行复杂查询。

内容抓取器

Content Grabber 是一款面向企业的网络爬虫软件。它允许您创建一个独立的网络爬虫代理。它可以从几乎所有网站 中提取内容,并以您选择的格式将其保存为结构化数据,包括 Excel 报告、XML、CSV 和大多数数据库。

因为它为需要的人提供了许多强大的脚本编辑和调试接口,所以更适合具有高级编程技能的人。允许用户使用 C# 或 VB.NET 调试或编写脚本来控制抓取过程的编程。例如,Content Grabber 可以与 Visual Studio 2013 集成,根据用户的特定需求,对高级、机智的自定义爬虫执行最强大的脚本编辑、调试和单元测试。

氦气刮刀

Helium Scraper 是一款可视化的网络数据爬取软件,当元素之间的相关性较小时效果很好。它是非编码和不可配置的。用户可以根据各种爬取需求访问在线模板。

基本上可以满足用户群的爬取需求。

路径

UiPath 是一款用于免费网络爬虫的机器人流程自动化软件。它可以从大多数第三方应用程序中自动抓取 Web 和桌面数据。如果在 Windows 上运行它,则可以安装自动化流程自动化软件。Uipath 可以跨多个网页以表格格式提取数据。

Uipath 提供了用于进一步爬行的内置工具。这种方法在处理复杂的 UI 时非常有效。截屏工具可以处理单个文本元素、文本组和文本块,例如表格格式的数据提取。

此外,无需编程即可创建智能 Web 代理,但您的内部 .NET 黑客将完全控制数据。

抓取.it

Scrape.it 是一个 node.js 网页抓取软件。这是一个基于云的数据提取工具。它是为具有高级编程技能的人设计的,因为它提供了公共和私有包来发现、重用、更新和与全球数百万开发人员共享代码。其强大的集成将帮助您根据需要构建自定义搜索引擎。

网络哈维

WebHarvy 是一种点击式网页抓取软件。它是为非程序员设计的。WebHarvy 可以自动抓取 网站 中的文本、图像、URL 和电子邮件,并将抓取的内容以各种格式保存。它还提供了内置的调度器和代理支持,可以进行匿名爬网,防止网络爬虫软件被网络服务器拦截。您可以选择通过代理服务器或 VPN 访问目标。

用户可以以多种格式保存从网页中提取的数据。当前版本的 WebHarvy 网络爬虫工具允许您将爬取的数据导出为 XML、CSV、JSON 或 TSV 文件。用户还可以将捕获的数据导出到 SQL 数据库。

内涵

Connotate 是一个自动化的网络爬虫程序,专为企业级 Web 内容提取而设计。它需要企业级解决方案。业务用户无需任何编程即可在几分钟内轻松创建提取代理。用户只需单击一下即可轻松创建提取代理。

抓取网页数据php(数据分析机器学习bizcomputer-central-by-ai脚本和浏览器地址栏显示数据)

网站优化 • 优采云 发表了文章 • 0 个评论 • 50 次浏览 • 2021-12-15 05:03

抓取网页数据php浏览器自带的cookie,javascript脚本和浏览器地址栏显示数据

第一次回答,说的不好欢迎打脸。html5,css3,javascript等,这些是最基础的了。视频的话就推荐两个:网易云课堂、欧阳宏伟的博客。图片的话直接去下载高清图片做壁纸吧,有很多。关于js可以在我的博客里面找到。

可以找下我或者各位牛人,

qq群453446009

推荐一个网站:cvflow|computervisionandnaturallanguage,开源的,像素级别的复现视频流之类的,去学学吧。

数据分析机器学习bizcomputer-central-by-ai

我用的是coursera上的中文课程网。

貌似图像是cv2

不是写过网页爬虫么???

看一本c++的《concretevisualprogramming》

爬虫的话,据说国内的博客里有个叫狼哥的人做了一个爬虫,但是是基于谷歌大图搜索开发的。这个多好爬啊,只要懂得用google,各种数据库,各种浏览器兼容,各种格式转换,各种黑名单白名单,各种逻辑查询,代码量少,花销不大,

推荐一个有意思的项目:《菜鸟python教程》

你现在python3应该已经可以了吧。github搜shopify。如果你不嫌麻烦的话还是可以自己试试手写爬虫,爬一下各大网站的。 查看全部

抓取网页数据php(数据分析机器学习bizcomputer-central-by-ai脚本和浏览器地址栏显示数据)

抓取网页数据php浏览器自带的cookie,javascript脚本和浏览器地址栏显示数据

第一次回答,说的不好欢迎打脸。html5,css3,javascript等,这些是最基础的了。视频的话就推荐两个:网易云课堂、欧阳宏伟的博客。图片的话直接去下载高清图片做壁纸吧,有很多。关于js可以在我的博客里面找到。

可以找下我或者各位牛人,

qq群453446009

推荐一个网站:cvflow|computervisionandnaturallanguage,开源的,像素级别的复现视频流之类的,去学学吧。

数据分析机器学习bizcomputer-central-by-ai

我用的是coursera上的中文课程网。

貌似图像是cv2

不是写过网页爬虫么???

看一本c++的《concretevisualprogramming》

爬虫的话,据说国内的博客里有个叫狼哥的人做了一个爬虫,但是是基于谷歌大图搜索开发的。这个多好爬啊,只要懂得用google,各种数据库,各种浏览器兼容,各种格式转换,各种黑名单白名单,各种逻辑查询,代码量少,花销不大,

推荐一个有意思的项目:《菜鸟python教程》

你现在python3应该已经可以了吧。github搜shopify。如果你不嫌麻烦的话还是可以自己试试手写爬虫,爬一下各大网站的。

抓取网页数据php( junjie这篇文章主要介绍了,_CUSTOMREQUEST参数的运用(图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 64 次浏览 • 2021-12-14 21:03

junjie这篇文章主要介绍了,_CUSTOMREQUEST参数的运用(图))

PHP curl 实现302跳转后抓取页面的例子

更新时间:2014-07-04 10:43:25 投稿:俊杰

本文文章主要介绍PHP curl实现302跳转后的页面的例子,主要是CURLOPT_CUSTOMREQUEST参数的使用,需要的朋友可以参考

PHP的CURL正常抓取页面程序如下:

$url = 'http://www.baidu.com';

$ch = curl_init();

curl_setopt($ch, CURLOPT_URL, $url);

curl_setopt($ch, CURLOPT_VERBOSE, true);

curl_setopt($ch, CURLOPT_HEADER, true);

curl_setopt($ch, CURLOPT_NOBODY, true);

curl_setopt($ch, CURLOPT_CUSTOMREQUEST, 'GET');

curl_setopt($ch, CURLOPT_RETURNTRANSFER, true);

curl_setopt($ch, CURLOPT_TIMEOUT, 20);

curl_setopt($ch, CURLOPT_AUTOREFERER, true);

curl_setopt($ch, CURLOPT_FOLLOWLOCATION, true);

$ret = curl_exec($ch);

$info = curl_getinfo($ch);

curl_close($ch);

如果抓取到302状态,那是因为在爬取过程中,有些跳转需要给下一个链接传递参数,如果没有收到相应的参数,下一个链接也被设置了,就是非法访问。

curl_setopt($curl, CURLOPT_CUSTOMREQUEST, 'GET');

显示应该是正常的。

上面是用来抓取函数的,应该几乎没有问题。您可以查看 CURLOPT_CUSTOMREQUEST 相关信息。

使用自定义请求消息而不是“GET”或“HEAD”作为 HTTP 请求。这是用于执行“DELETE”或其他更模糊的 HTTP 请求。有效值为“GET”、“POST”、“CONNECT”等。换句话说,不要在此处输入整个 HTTP 请求。例如,输入“GET /index.html HTTP/1.0\r\n\r\n”是错误的。 查看全部

抓取网页数据php(

junjie这篇文章主要介绍了,_CUSTOMREQUEST参数的运用(图))

PHP curl 实现302跳转后抓取页面的例子

更新时间:2014-07-04 10:43:25 投稿:俊杰

本文文章主要介绍PHP curl实现302跳转后的页面的例子,主要是CURLOPT_CUSTOMREQUEST参数的使用,需要的朋友可以参考

PHP的CURL正常抓取页面程序如下:

$url = 'http://www.baidu.com';

$ch = curl_init();

curl_setopt($ch, CURLOPT_URL, $url);

curl_setopt($ch, CURLOPT_VERBOSE, true);

curl_setopt($ch, CURLOPT_HEADER, true);

curl_setopt($ch, CURLOPT_NOBODY, true);

curl_setopt($ch, CURLOPT_CUSTOMREQUEST, 'GET');

curl_setopt($ch, CURLOPT_RETURNTRANSFER, true);

curl_setopt($ch, CURLOPT_TIMEOUT, 20);

curl_setopt($ch, CURLOPT_AUTOREFERER, true);

curl_setopt($ch, CURLOPT_FOLLOWLOCATION, true);

$ret = curl_exec($ch);

$info = curl_getinfo($ch);

curl_close($ch);

如果抓取到302状态,那是因为在爬取过程中,有些跳转需要给下一个链接传递参数,如果没有收到相应的参数,下一个链接也被设置了,就是非法访问。

curl_setopt($curl, CURLOPT_CUSTOMREQUEST, 'GET');

显示应该是正常的。

上面是用来抓取函数的,应该几乎没有问题。您可以查看 CURLOPT_CUSTOMREQUEST 相关信息。

使用自定义请求消息而不是“GET”或“HEAD”作为 HTTP 请求。这是用于执行“DELETE”或其他更模糊的 HTTP 请求。有效值为“GET”、“POST”、“CONNECT”等。换句话说,不要在此处输入整个 HTTP 请求。例如,输入“GET /index.html HTTP/1.0\r\n\r\n”是错误的。

抓取网页数据php(本文就用Java给大家演示怎样抓取站点的数据:(1))

网站优化 • 优采云 发表了文章 • 0 个评论 • 46 次浏览 • 2021-12-14 00:19

原文链接:

有时因为各种原因。我们需要从某个站点采集数据。但是因为不同的站点显示的数据略有不同!

本文使用Java向大家展示如何抓取网站的数据:(1)抓取原创网页数据。(2)抓取网页Javascript返回的数据。

一、 抓取原创网页。

在这个例子中,我们将从上面获取 ip 查询的结果:

第一步:打开这个网页。然后输入IP:111.142.55.73,点击查询按钮。您将能够看到网页上显示的结果:

第二步:查看网页源代码,我们在源代码中看到这一段:

从这里可以看到。再次请求网页后显示查询结果。

查询后看网页地址:

换句话说,我们只需要访问一个看起来像这样的 URL。可以得到ip查询的结果,然后看代码:

public void captureHtml(String ip) throws Exception {

String strURL = "http://ip.chinaz.com/?

<p>IP=" + ip;

URL url = new URL(strURL);

HttpURLConnection httpConn = (HttpURLConnection) url.openConnection();

InputStreamReader input = new InputStreamReader(httpConn

.getInputStream(), "utf-8");

BufferedReader bufReader = new BufferedReader(input);

String line = "";

StringBuilder contentBuf = new StringBuilder();

while ((line = bufReader.readLine()) != null) {

contentBuf.append(line);

}

String buf = contentBuf.toString();

int beginIx = buf.indexOf("查询结果[");

int endIx = buf.indexOf("上面四项依次显示的是");

String result = buf.substring(beginIx, endIx);

System.out.println("captureHtml()的结果:\n" + result);

}</p>

使用 HttpURLConnection 连接到站点。使用bufReader保存网页返回的数据,然后通过自己定义的解析方法显示结果。

这里我只是随便解析了一下,想要解析准确,就需要自己处理了。

分析结果如下:

captureHtml() 的结果:

查询结果[1]:111.142.55.73 ==>> 1871591241 ==>> 福建省漳州市手机

二、 抓取网页的 JavaScript 返回的结果。

有时,网站为了保护自己的数据,不会直接在网页的源代码中返回数据,而是采用异步的方式。使用JS返回数据,可以避免网站数据被搜索引擎等工具抓取。

首先看这个页面:

我用第一种方法查看网页源代码,但是没有找到运单的跟踪信息,因为是通过JS获取的结果。

但是有时候我们非常需要获取JS数据,这个时候我们该怎么办呢?

这时候我们就需要用到一个工具:HTTP Analyzer,这个工具可以拦截Http的交互内容,我们使用这个工具来达到我们的目的。

首先点击开始按钮后,它开始监控网页的交互行为。

我们打开网页:,可以看到HTTP Analyzer列出了网页的所有请求数据和结果:

为了更方便的查看JS的结果,我们先清空这些数据,然后在网页中输入快递号:7。单击查询按钮,然后查看 HTTP Analyzer 的结果:

这是点击查询按钮后HTTP Analyzer的结果。让我们继续检查:

从上面两张图可以看出。HTTP Analyzer 可以截取 JS 返回的数据并显示在 Response Content 中。同时可以看到JS请求的网页地址。

既然如此。我们只需要分析HTTP Analyzer的结果,然后模拟JS的行为来获取数据,即我们只需要访问JS请求的网页地址就可以获取数据。当然,前提是这些数据没有加密。我们记下JS请求的URL:

然后让程序请求这个页面的结果!

这是代码:

public void captureJavascript(String postid) throws Exception {

String strURL = "http://www.kiees.cn/sf.php?

<p>wen=" + postid

+ "&channel=&rnd=0";

URL url = new URL(strURL);

HttpURLConnection httpConn = (HttpURLConnection) url.openConnection();

InputStreamReader input = new InputStreamReader(httpConn

.getInputStream(), "utf-8");

BufferedReader bufReader = new BufferedReader(input);

String line = "";

StringBuilder contentBuf = new StringBuilder();

while ((line = bufReader.readLine()) != null) {

contentBuf.append(line);

}

System.out.println("captureJavascript()的结果:\n" + contentBuf.toString());

}</p>

看见。抓取JS的方法和之前抓取原创网页的代码完全一样。我们只是做了一个分析JS的过程。

下面是程序运行的结果:

captureJavascript() 的结果:

运单跟踪信息 [7]

这些数据就是JS返回的结果,我们的目的就达到了!

希望本文能成为需要帮助的孩子和程序的源代码,点此下载! 查看全部

抓取网页数据php(本文就用Java给大家演示怎样抓取站点的数据:(1))

原文链接:

有时因为各种原因。我们需要从某个站点采集数据。但是因为不同的站点显示的数据略有不同!

本文使用Java向大家展示如何抓取网站的数据:(1)抓取原创网页数据。(2)抓取网页Javascript返回的数据。

一、 抓取原创网页。

在这个例子中,我们将从上面获取 ip 查询的结果:

第一步:打开这个网页。然后输入IP:111.142.55.73,点击查询按钮。您将能够看到网页上显示的结果:

第二步:查看网页源代码,我们在源代码中看到这一段:

从这里可以看到。再次请求网页后显示查询结果。

查询后看网页地址:

换句话说,我们只需要访问一个看起来像这样的 URL。可以得到ip查询的结果,然后看代码:

public void captureHtml(String ip) throws Exception {

String strURL = "http://ip.chinaz.com/?

<p>IP=" + ip;

URL url = new URL(strURL);

HttpURLConnection httpConn = (HttpURLConnection) url.openConnection();

InputStreamReader input = new InputStreamReader(httpConn

.getInputStream(), "utf-8");

BufferedReader bufReader = new BufferedReader(input);

String line = "";

StringBuilder contentBuf = new StringBuilder();

while ((line = bufReader.readLine()) != null) {

contentBuf.append(line);

}

String buf = contentBuf.toString();

int beginIx = buf.indexOf("查询结果[");

int endIx = buf.indexOf("上面四项依次显示的是");

String result = buf.substring(beginIx, endIx);

System.out.println("captureHtml()的结果:\n" + result);

}</p>

使用 HttpURLConnection 连接到站点。使用bufReader保存网页返回的数据,然后通过自己定义的解析方法显示结果。

这里我只是随便解析了一下,想要解析准确,就需要自己处理了。

分析结果如下:

captureHtml() 的结果:

查询结果[1]:111.142.55.73 ==>> 1871591241 ==>> 福建省漳州市手机

二、 抓取网页的 JavaScript 返回的结果。

有时,网站为了保护自己的数据,不会直接在网页的源代码中返回数据,而是采用异步的方式。使用JS返回数据,可以避免网站数据被搜索引擎等工具抓取。

首先看这个页面:

我用第一种方法查看网页源代码,但是没有找到运单的跟踪信息,因为是通过JS获取的结果。

但是有时候我们非常需要获取JS数据,这个时候我们该怎么办呢?

这时候我们就需要用到一个工具:HTTP Analyzer,这个工具可以拦截Http的交互内容,我们使用这个工具来达到我们的目的。

首先点击开始按钮后,它开始监控网页的交互行为。

我们打开网页:,可以看到HTTP Analyzer列出了网页的所有请求数据和结果:

为了更方便的查看JS的结果,我们先清空这些数据,然后在网页中输入快递号:7。单击查询按钮,然后查看 HTTP Analyzer 的结果:

这是点击查询按钮后HTTP Analyzer的结果。让我们继续检查:

从上面两张图可以看出。HTTP Analyzer 可以截取 JS 返回的数据并显示在 Response Content 中。同时可以看到JS请求的网页地址。

既然如此。我们只需要分析HTTP Analyzer的结果,然后模拟JS的行为来获取数据,即我们只需要访问JS请求的网页地址就可以获取数据。当然,前提是这些数据没有加密。我们记下JS请求的URL:

然后让程序请求这个页面的结果!

这是代码:

public void captureJavascript(String postid) throws Exception {

String strURL = "http://www.kiees.cn/sf.php?

<p>wen=" + postid

+ "&channel=&rnd=0";

URL url = new URL(strURL);

HttpURLConnection httpConn = (HttpURLConnection) url.openConnection();

InputStreamReader input = new InputStreamReader(httpConn

.getInputStream(), "utf-8");

BufferedReader bufReader = new BufferedReader(input);

String line = "";

StringBuilder contentBuf = new StringBuilder();

while ((line = bufReader.readLine()) != null) {

contentBuf.append(line);

}

System.out.println("captureJavascript()的结果:\n" + contentBuf.toString());

}</p>

看见。抓取JS的方法和之前抓取原创网页的代码完全一样。我们只是做了一个分析JS的过程。

下面是程序运行的结果:

captureJavascript() 的结果:

运单跟踪信息 [7]

这些数据就是JS返回的结果,我们的目的就达到了!

希望本文能成为需要帮助的孩子和程序的源代码,点此下载!

抓取网页数据php(做过j2ee或android开发的童鞋,应该或多或少都使用过Apeache的HttpClient类库)

网站优化 • 优采云 发表了文章 • 0 个评论 • 69 次浏览 • 2021-11-30 08:13

做过j2ee或者android开发的童鞋,应该或多或少用过Apeache的HttpClient库。这个类库为我们提供了非常强大的服务端Http请求操作。在开发中使用非常方便。

在最近的php开发中,也有需要在服务端发送http请求,然后处理返回给客户端。如果用sockets来做,可能不会太麻烦。我想看看php中有没有像HttpClient这样的库。

google了一下,发现PHP中有这样一个库,名字叫httpclient。我很兴奋。看了官网,发现很多年没更新了,功能好像也有限。我很失望。然后我找到了另一个图书馆,史努比。我对这个库一无所知,但是网上反响很好,所以我决定使用它。他的API用法和Apeache的HttpClient有很大的不同,但是还是非常好用的。它还提供了很多特殊用途的方法,比如只抓取页面上的表单表单,或者所有的链接等等。

include 'Snoopy.class.php';

$snoopy = new Snoopy();

$snoopy->fetch("http://www.baidu.com");

echo $snoopy->results;

有了上面几行代码,就可以轻松抓取百度的页面了。

当然,当需要发送post表单时,可以使用submit方法提交数据。

同时还提供了请求头、响应头和Cookie相关的操作功能,功能非常强大。

\n";} else {echo "error fetching document: ". $snoopy->error. "\n";}

更多操作方法可以去史努比官方文档,或者直接查看源码。

此时,snoopy 只是将页面取回。如果您想从获取的页面中提取数据,那么它不会有太大帮助。在这里我找到了另一个很好的php解析HTML的工具:phpQuery,它提供了和jquery几乎一样的操作方法,并且提供了一些php的特性。对于熟悉jquery的小朋友来说,使用phpquery应该是相当容易的,甚至phpQuery的文件都不需要了。。

使用Snoopy+PhpQuery可以轻松实现网页抓取和数据分析。这是非常有用的。最近也有这方面的需求,发现了这两个不错的库。Java 可以做很多事情。php也可以。

有兴趣的同学也可以尝试用它们来制作一个简单的网络爬虫。 查看全部

抓取网页数据php(做过j2ee或android开发的童鞋,应该或多或少都使用过Apeache的HttpClient类库)

做过j2ee或者android开发的童鞋,应该或多或少用过Apeache的HttpClient库。这个类库为我们提供了非常强大的服务端Http请求操作。在开发中使用非常方便。

在最近的php开发中,也有需要在服务端发送http请求,然后处理返回给客户端。如果用sockets来做,可能不会太麻烦。我想看看php中有没有像HttpClient这样的库。

google了一下,发现PHP中有这样一个库,名字叫httpclient。我很兴奋。看了官网,发现很多年没更新了,功能好像也有限。我很失望。然后我找到了另一个图书馆,史努比。我对这个库一无所知,但是网上反响很好,所以我决定使用它。他的API用法和Apeache的HttpClient有很大的不同,但是还是非常好用的。它还提供了很多特殊用途的方法,比如只抓取页面上的表单表单,或者所有的链接等等。

include 'Snoopy.class.php';

$snoopy = new Snoopy();

$snoopy->fetch("http://www.baidu.com";);

echo $snoopy->results;

有了上面几行代码,就可以轻松抓取百度的页面了。

当然,当需要发送post表单时,可以使用submit方法提交数据。

同时还提供了请求头、响应头和Cookie相关的操作功能,功能非常强大。

\n";} else {echo "error fetching document: ". $snoopy->error. "\n";}

更多操作方法可以去史努比官方文档,或者直接查看源码。

此时,snoopy 只是将页面取回。如果您想从获取的页面中提取数据,那么它不会有太大帮助。在这里我找到了另一个很好的php解析HTML的工具:phpQuery,它提供了和jquery几乎一样的操作方法,并且提供了一些php的特性。对于熟悉jquery的小朋友来说,使用phpquery应该是相当容易的,甚至phpQuery的文件都不需要了。。

使用Snoopy+PhpQuery可以轻松实现网页抓取和数据分析。这是非常有用的。最近也有这方面的需求,发现了这两个不错的库。Java 可以做很多事情。php也可以。

有兴趣的同学也可以尝试用它们来制作一个简单的网络爬虫。

抓取网页数据php(如何用python来抓取页面中的JS动态加载的数据 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 66 次浏览 • 2021-11-23 10:07

)

我们经常发现网页中的很多数据并不是硬编码在HTML中,而是通过js动态加载的。所以也引出了动态数据的概念。这里的动态数据是指网页中Javascript动态生成的页面内容,是页面加载到浏览器后动态生成的,以前是没有的。

在编写爬虫抓取网页数据的时候,经常会遇到这种需要动态加载数据的HTML网页。如果你还是直接从网页上爬取,你将无法获取任何数据。

今天,我们就在这里简单说说如何使用python抓取页面中JS动态加载的数据。

给定一个网页:豆瓣电影排行榜,里面的所有电影信息都是动态加载的。我们无法直接从页面中获取每部电影的信息。

如下图,我们在HTML中找不到对应的电影信息。

在Chrome浏览器中,点击F12打开Network中的XHR,我们抓取对应的js文件进行分析。如下所示:

在豆瓣页面向下拖动,可以将更多的电影信息加载到页面中,以便我们抓取相应的消息。

我们可以看到它使用了AJAX异步请求。通过在后台与服务器交换少量数据,AJAX 可以使网页异步更新。因此,可以在不重新加载整个网页的情况下更新网页的某一部分,从而实现数据的动态加载。

我们可以看到,通过GET,我们得到的响应中收录了对应的电影相关信息,以JSON格式存储在一起。

查看RequestURL信息,可以发现action参数后面有“start”和“limit”两个参数。显然他们的意思是:“从某个位置返回的电影数量”。

如果你想快速获取相关电影信息,可以直接把这个网址复制到地址栏,修改你需要的start和limit参数值,得到相应的抓取结果。

但这不是很自动,很多其他的网站 RequestURL 也不是那么简单,所以我们将使用python 进行进一步的操作来获取返回的消息信息。

#coding:utf-8

import urllib

import requests

post_param = {\'action\':\'\',\'start\':\'0\',\'limit\':\'1\'}

return_data = requests.get("https://movie.douban.com/j/cha ... ot%3B,data =post_param, verify = False)

print return_data.text 查看全部

抓取网页数据php(如何用python来抓取页面中的JS动态加载的数据

)

我们经常发现网页中的很多数据并不是硬编码在HTML中,而是通过js动态加载的。所以也引出了动态数据的概念。这里的动态数据是指网页中Javascript动态生成的页面内容,是页面加载到浏览器后动态生成的,以前是没有的。

在编写爬虫抓取网页数据的时候,经常会遇到这种需要动态加载数据的HTML网页。如果你还是直接从网页上爬取,你将无法获取任何数据。

今天,我们就在这里简单说说如何使用python抓取页面中JS动态加载的数据。

给定一个网页:豆瓣电影排行榜,里面的所有电影信息都是动态加载的。我们无法直接从页面中获取每部电影的信息。

如下图,我们在HTML中找不到对应的电影信息。

在Chrome浏览器中,点击F12打开Network中的XHR,我们抓取对应的js文件进行分析。如下所示:

在豆瓣页面向下拖动,可以将更多的电影信息加载到页面中,以便我们抓取相应的消息。

我们可以看到它使用了AJAX异步请求。通过在后台与服务器交换少量数据,AJAX 可以使网页异步更新。因此,可以在不重新加载整个网页的情况下更新网页的某一部分,从而实现数据的动态加载。

我们可以看到,通过GET,我们得到的响应中收录了对应的电影相关信息,以JSON格式存储在一起。

查看RequestURL信息,可以发现action参数后面有“start”和“limit”两个参数。显然他们的意思是:“从某个位置返回的电影数量”。

如果你想快速获取相关电影信息,可以直接把这个网址复制到地址栏,修改你需要的start和limit参数值,得到相应的抓取结果。

但这不是很自动,很多其他的网站 RequestURL 也不是那么简单,所以我们将使用python 进行进一步的操作来获取返回的消息信息。

#coding:utf-8

import urllib

import requests

post_param = {\'action\':\'\',\'start\':\'0\',\'limit\':\'1\'}

return_data = requests.get("https://movie.douban.com/j/cha ... ot%3B,data =post_param, verify = False)

print return_data.text

抓取网页数据php(北京信息职业技术学院|非完全PageRank策略(PartialPageRank))

网站优化 • 优采云 发表了文章 • 0 个评论 • 58 次浏览 • 2021-11-23 06:08

不完整的PageRank策略北京信息学院| 郑树辉易信PageRank概述1、PageRank算法:是一种著名的链接分析算法。在网络爬虫中,利用PageRank的思想对URL优先级进行排序。2、PageRank 是一种全局算法。当所有网页都下载后,计算结果是可靠的。网页在爬行阶段无法获得可靠的PageRank值。2 不完全PageRank(PartialPageRank)概述 PartialPageRank算法借鉴了PageRank算法的思想:根据一定的网页分析算法,预测候选网址与目标网页的相似度,或与主题的相关性,并选择最好的一个或多个网址进行爬取,即对于下载的网页,连同要爬取的URL队列中的URL,形成一个网页集合,计算每个页面的PageRank值,计算完成后,要爬取的URL队列中的URL基于PageRank的值按数量级排列,并按该顺序抓取页面。3 不完整的PageRank 策略 它只访问被网络分析算法预测为“有用”的网页。一个问题是爬虫的爬取路径中很多相关的网页可能会被忽略,因为最好的优先级策略是局部最优搜索算法。因此,需要将最佳优先级与具体应用结合起来进行改进,才能跳出局部最佳。研究表明,这样的闭环调整可以将不相关网页的数量减少30%到90%。4 不完整的PageRank策略如果每次爬取一个页面,都会重新计算PageRank值,效率低下。一个折衷的解决方案是每次获取 K 个页面时重新计算 PageRank 值。但是,在这种情况下仍然存在一个问题:对于下载页面中分析的链接,即我们前面提到的未知网页部分,暂时没有PageRank值。为了解决这个问题,这些页面会被赋予一个临时的PageRank值:将所有传入该页面链的PageRank值汇总,从而形成未知页面的PageRank值,参与排名. 查看全部

抓取网页数据php(北京信息职业技术学院|非完全PageRank策略(PartialPageRank))

不完整的PageRank策略北京信息学院| 郑树辉易信PageRank概述1、PageRank算法:是一种著名的链接分析算法。在网络爬虫中,利用PageRank的思想对URL优先级进行排序。2、PageRank 是一种全局算法。当所有网页都下载后,计算结果是可靠的。网页在爬行阶段无法获得可靠的PageRank值。2 不完全PageRank(PartialPageRank)概述 PartialPageRank算法借鉴了PageRank算法的思想:根据一定的网页分析算法,预测候选网址与目标网页的相似度,或与主题的相关性,并选择最好的一个或多个网址进行爬取,即对于下载的网页,连同要爬取的URL队列中的URL,形成一个网页集合,计算每个页面的PageRank值,计算完成后,要爬取的URL队列中的URL基于PageRank的值按数量级排列,并按该顺序抓取页面。3 不完整的PageRank 策略 它只访问被网络分析算法预测为“有用”的网页。一个问题是爬虫的爬取路径中很多相关的网页可能会被忽略,因为最好的优先级策略是局部最优搜索算法。因此,需要将最佳优先级与具体应用结合起来进行改进,才能跳出局部最佳。研究表明,这样的闭环调整可以将不相关网页的数量减少30%到90%。4 不完整的PageRank策略如果每次爬取一个页面,都会重新计算PageRank值,效率低下。一个折衷的解决方案是每次获取 K 个页面时重新计算 PageRank 值。但是,在这种情况下仍然存在一个问题:对于下载页面中分析的链接,即我们前面提到的未知网页部分,暂时没有PageRank值。为了解决这个问题,这些页面会被赋予一个临时的PageRank值:将所有传入该页面链的PageRank值汇总,从而形成未知页面的PageRank值,参与排名.

抓取网页数据php(connect函数phpshell调用shell写入调用参数解析数据分析解析)

网站优化 • 优采云 发表了文章 • 0 个评论 • 66 次浏览 • 2021-11-11 19:01

抓取网页数据php解析数据,获取传入的参数,并渲染页面shell脚本:#php:requestrequest_body=string(request_text);#encode你的样式(按需选择shell脚本的样式):request_set_content(request_text,'form-data');#encode给某个参数加密(这个可以不加密,如果加密可以帮助更好的解密,所以这个参数是加密的):request_secret_base=request_body。

content。encode('');#encode给某个参数加密后的shell脚本代码:unconnected_the_auth_request('auth','users','password','xxxxxx');。

调用connect函数php调用shell写入表单参数。

php做一层公司的前端页面系统中,建立用户认证->登录->注册系统,三个步骤是通过一个服务器实现的。connect的函数用来调用这个服务器,所以你要了解connect函数的调用规则,也就是你要提供一个参数给它,你要通过什么格式或者什么方式来进行认证,以及你要通过什么方式来获取用户名,用户名可以通过username和password来间接获取,也可以通过spring来实现。

defconnect(username,password):ifnotisinstance(username,password):raiseexception('"connect"requestfailed!')else:#returnstringifnotisinstance(username,string):#raiseexception('"connect"requestsuccessfully!')else:#encodebaseencode(ext):#returnrequestreturn""。join(username,password)endif。 查看全部

抓取网页数据php(connect函数phpshell调用shell写入调用参数解析数据分析解析)

抓取网页数据php解析数据,获取传入的参数,并渲染页面shell脚本:#php:requestrequest_body=string(request_text);#encode你的样式(按需选择shell脚本的样式):request_set_content(request_text,'form-data');#encode给某个参数加密(这个可以不加密,如果加密可以帮助更好的解密,所以这个参数是加密的):request_secret_base=request_body。

content。encode('');#encode给某个参数加密后的shell脚本代码:unconnected_the_auth_request('auth','users','password','xxxxxx');。

调用connect函数php调用shell写入表单参数。

php做一层公司的前端页面系统中,建立用户认证->登录->注册系统,三个步骤是通过一个服务器实现的。connect的函数用来调用这个服务器,所以你要了解connect函数的调用规则,也就是你要提供一个参数给它,你要通过什么格式或者什么方式来进行认证,以及你要通过什么方式来获取用户名,用户名可以通过username和password来间接获取,也可以通过spring来实现。

defconnect(username,password):ifnotisinstance(username,password):raiseexception('"connect"requestfailed!')else:#returnstringifnotisinstance(username,string):#raiseexception('"connect"requestsuccessfully!')else:#encodebaseencode(ext):#returnrequestreturn""。join(username,password)endif。

抓取网页数据php(乐思网络信息采集和数据抓取市场最具影响力的六大品牌)

网站优化 • 优采云 发表了文章 • 0 个评论 • 99 次浏览 • 2021-11-03 18:19

近年来,随着国内大数据战略的日趋清晰,数据采集与信息化采集系列产品迎来了巨大的发展机遇,采集产品的数量也出现了快速增长。然而,与产品品类的快速增长相反,信息采集技术相对薄弱,市场竞争激烈,质量参差不齐。在此,本文列出当前信息采集以及数据采集市场最具影响力的六大品牌,供采购大数据和智能中心建设单位时参考:

TOP.1 乐思网络信息采集系统()

乐思网络信息采集系统的主要目标是解决网络信息采集和网络数据采集的问题。它基于用户自定义的任务配置,批量准确地从互联网目标网页中提取半结构化和非结构化数据,并转化为结构化记录,存储在本地数据库中,供内部使用或外网发布。快速获取外部信息。

系统主要用于:大数据基础设施建设、舆情监测、品牌监测、价格监测、门户网站新闻采集、行业资讯采集、竞争情报获取、业务数据整合、市场研究、数据库营销等领域。

TOP.2 优采云采集器()

优采云采集器是一款专业的网络数据采集/信息挖掘处理软件。通过灵活的配置,您可以轻松快速地从网页中抓取结构化文本、图片和图片。可以对文件等资源信息进行编辑过滤后发布到网站后台、各种文件或其他数据库系统。广泛应用于数据挖掘、垂直搜索、信息聚合与门户、企业网络信息聚合、商业智能、论坛或博客迁移、智能信息代理、个人信息检索等领域。采集探索有需要的群体。

TOP.3 优采云采集器软件()

优采云采集器软件利用熊猫精准搜索引擎的分析核心实现网页内容类似浏览器的分析,并在此基础上利用原创的技术实现框架网页内容和核心内容 相似页面的分离、提取、有效比较和匹配。因此,用户只需要指定一个参考页面,优采云采集器软件系统就可以在此基础上匹配相似的页面,从而实现批量所需的采集素材。用户采集。

TOP.4 优采云采集器()

优采云采集器是一套专业的网站内容采集软件,支持各种论坛发帖回复采集、网站和博客文章内容抓取,通过相关配置,您可以轻松使用采集80%的网站内容供自己使用。根据各种建站程序的不同,分为优采云采集器子论坛采集器、cms采集器和博客采集器三种类型@>,共支持近40种类型数百个版本的数据采集和主流建站程序的发布任务,支持图片本地化,支持网站登录采集,页面抓取,全面模拟人工登录发布,软件运行快捷安全稳定!

TOP.5 网络外观()

网络神彩是一个专业的网络信息采集系统。通过灵活的规则,您可以获取任何类型的网站采集信息,例如新闻网站、论坛、博客、电子商务网站、招聘网站等等。支持网站登录采集、网站跨层采集、POST采集、脚本页面采集、动态页面采集和其他高级采集功能。支持存储过程、插件等,可二次开发扩展功能。

TOP.6 蓝蜘蛛互联网采集系统()

蓝蜘蛛网采集系统不需要配置网站的入口URL。系统会根据用户输入的关键词自动通过主流搜索门户在整个互联网上进行元搜索,然后搜索结果页面就会采集下来。在采集的过程中,会根据预设的模板自动分析或过滤您感兴趣的内容、标题或信息项。 查看全部

抓取网页数据php(乐思网络信息采集和数据抓取市场最具影响力的六大品牌)

近年来,随着国内大数据战略的日趋清晰,数据采集与信息化采集系列产品迎来了巨大的发展机遇,采集产品的数量也出现了快速增长。然而,与产品品类的快速增长相反,信息采集技术相对薄弱,市场竞争激烈,质量参差不齐。在此,本文列出当前信息采集以及数据采集市场最具影响力的六大品牌,供采购大数据和智能中心建设单位时参考:

TOP.1 乐思网络信息采集系统()

乐思网络信息采集系统的主要目标是解决网络信息采集和网络数据采集的问题。它基于用户自定义的任务配置,批量准确地从互联网目标网页中提取半结构化和非结构化数据,并转化为结构化记录,存储在本地数据库中,供内部使用或外网发布。快速获取外部信息。

系统主要用于:大数据基础设施建设、舆情监测、品牌监测、价格监测、门户网站新闻采集、行业资讯采集、竞争情报获取、业务数据整合、市场研究、数据库营销等领域。

TOP.2 优采云采集器()

优采云采集器是一款专业的网络数据采集/信息挖掘处理软件。通过灵活的配置,您可以轻松快速地从网页中抓取结构化文本、图片和图片。可以对文件等资源信息进行编辑过滤后发布到网站后台、各种文件或其他数据库系统。广泛应用于数据挖掘、垂直搜索、信息聚合与门户、企业网络信息聚合、商业智能、论坛或博客迁移、智能信息代理、个人信息检索等领域。采集探索有需要的群体。

TOP.3 优采云采集器软件()

优采云采集器软件利用熊猫精准搜索引擎的分析核心实现网页内容类似浏览器的分析,并在此基础上利用原创的技术实现框架网页内容和核心内容 相似页面的分离、提取、有效比较和匹配。因此,用户只需要指定一个参考页面,优采云采集器软件系统就可以在此基础上匹配相似的页面,从而实现批量所需的采集素材。用户采集。

TOP.4 优采云采集器()

优采云采集器是一套专业的网站内容采集软件,支持各种论坛发帖回复采集、网站和博客文章内容抓取,通过相关配置,您可以轻松使用采集80%的网站内容供自己使用。根据各种建站程序的不同,分为优采云采集器子论坛采集器、cms采集器和博客采集器三种类型@>,共支持近40种类型数百个版本的数据采集和主流建站程序的发布任务,支持图片本地化,支持网站登录采集,页面抓取,全面模拟人工登录发布,软件运行快捷安全稳定!

TOP.5 网络外观()

网络神彩是一个专业的网络信息采集系统。通过灵活的规则,您可以获取任何类型的网站采集信息,例如新闻网站、论坛、博客、电子商务网站、招聘网站等等。支持网站登录采集、网站跨层采集、POST采集、脚本页面采集、动态页面采集和其他高级采集功能。支持存储过程、插件等,可二次开发扩展功能。

TOP.6 蓝蜘蛛互联网采集系统()

蓝蜘蛛网采集系统不需要配置网站的入口URL。系统会根据用户输入的关键词自动通过主流搜索门户在整个互联网上进行元搜索,然后搜索结果页面就会采集下来。在采集的过程中,会根据预设的模板自动分析或过滤您感兴趣的内容、标题或信息项。

抓取网页数据php(php解决方案:如果两者之间有解绑绑,只能帮你实践一下)

网站优化 • 优采云 发表了文章 • 0 个评论 • 58 次浏览 • 2021-11-01 12:44

抓取网页数据php需要web服务器的配置,

我也遇到类似的问题。可能是开发对运维说你的数据存储在xxxfile里,需要改一下xxxfile的配置文件的路径。如果没改过配置文件,请确认你的数据存储路径有没有写对。这个问题我觉得好麻烦,已经折腾了2天了。刚刚在搜索答案中得到一个解决方案:如果两者之间有解绑解绑解绑,记得改下它本身的路径。另外,你这个问题,我似乎没解决方案,只能帮你实践一下,如果不错我再说说我是怎么解决的。如果这个方法行不通,请告诉我,我来找找看有没有更好的方法。

看了2个答案,不适用于这个问题。这个问题遇到过很多次了,解决办法是nosql,一般是redis,可以直接部署webserver,

你需要先找sqlserver的defaultschema。

excel格式数据就可以,

把windows/linux环境变量configinfo以及其他路径(foo.excel)装在系统里。对,linux是sudo,

你把linux设置成localhost试试

server_name中的foo.excel改成foo.linux就是foo.sql,之前没看说明书,我是用正则表达式匹配出来的,其中table="powerbi"是准确的用read_excel方法获取的, 查看全部

抓取网页数据php(php解决方案:如果两者之间有解绑绑,只能帮你实践一下)

抓取网页数据php需要web服务器的配置,

我也遇到类似的问题。可能是开发对运维说你的数据存储在xxxfile里,需要改一下xxxfile的配置文件的路径。如果没改过配置文件,请确认你的数据存储路径有没有写对。这个问题我觉得好麻烦,已经折腾了2天了。刚刚在搜索答案中得到一个解决方案:如果两者之间有解绑解绑解绑,记得改下它本身的路径。另外,你这个问题,我似乎没解决方案,只能帮你实践一下,如果不错我再说说我是怎么解决的。如果这个方法行不通,请告诉我,我来找找看有没有更好的方法。

看了2个答案,不适用于这个问题。这个问题遇到过很多次了,解决办法是nosql,一般是redis,可以直接部署webserver,

你需要先找sqlserver的defaultschema。

excel格式数据就可以,

把windows/linux环境变量configinfo以及其他路径(foo.excel)装在系统里。对,linux是sudo,

你把linux设置成localhost试试

server_name中的foo.excel改成foo.linux就是foo.sql,之前没看说明书,我是用正则表达式匹配出来的,其中table="powerbi"是准确的用read_excel方法获取的,

抓取网页数据php(百度网站排名和互链有什么区别?怎么做?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 68 次浏览 • 2021-10-20 22:05

1、网站的2113个死链接可以通过站长工具或5261 4102Xenu查看。网站死链查询工具1653查询,可以直接使用chianz查询工具,也可以下载其他站长工具,比如从爱站网站下载,或者金华站长工具。

nae sarang eun oh jik keu dae boon jeh gga ji na moh deun keol joo go ship peo

外部优化

3、标签优化:

控制外链来源,保证链接质量

6.2.3. 域轰炸

三、尤溪县网站被黑相关说明

具体域名托管服务根据不同行业、公司网站基金会和客户需求定制。以下是尤溪县常见的网站被黑服务内容:

百度石榴算法:石榴算法主要针对低质量页面,其中百度蜘蛛主要根据网站html代码抓取,搜索引擎基于标签(包括排版)和重复文章的阅读来判断网站的好坏。百度的网站 排名。百度的网站 排名。百度的网站 排名。

友情链接和相互链接有什么区别?

但可能会受到资金等问题的限制,所以这项工作交给了其他工作室或团队来完成。

1.通过内容自然吸引粉丝

曾经听网上说新网站前期不要建太多外链。对于这个说法,新网站本身没有流量,也没有权重。如果此时不增加外链的建设,那么网站的流量和权重会提升得很慢,网站获得排名的时间会更长。只要外链网站是正规站点,并且具有一定的质量网站,那么外链越多越好。它也将被搜索引擎赞赏。

四、尤溪县网络品牌营销-延伸阅读

1、在一定时间内多次点击同一个IP地址只计为一次有效点击

未来,在入站营销下,我们可以做四件事:

禁止:.png$

做百度竞价推广,一般要分析以下数据:

3、在对话框中输入要查询的网址,点击“查询”。

14.关键词索引其实就是百度。GG查询更符合你网站的关键词。每天的用户查询次数用于判断该关键字是否具有高查询率。这就是流行和不流行的区别。

这是SEO最重要的部分。关键词分析包括:关键词搜索量分析、竞争对手分析、关键词和项目关联分析、关键词布局、关键词@关键词排名预测。

百度SEO优化,百度搜索首页什么样的网站

1、反链的锚文本不应该只是一个核心关键词,尽量分散关键词。反向链接。

元标记是嵌入在您的网页中的特殊 html 标记,其中收录有关您网页的一些隐藏信息。Meat 标签的功能是向搜索引擎解释您的网页是关于什么信息的。对于高级搜索引擎,html 元标记并不是什么新鲜事。谷歌搜索引擎优化。但无论如何它对于一个好的网页来说是必不可少的。让我们在下面解释其中的一些。

五、尤溪县个人网站模板-延伸阅读

5、 当对方决定加入时,他们还是喋喋不休或欣喜若狂,表现得冷静专注。网站营销计划。

注册成为百度指数用户,需要获得百度指数邀请函。百度指数创建。如果您已收到邀请函,请点击邀请函中的注册链接申请注册。百度指数创建。百度指数创建。注册后即可享受百度指数所有尊贵服务。百度指数创建。

17、QQ和MSN昵称推广方式:修改昵称到网址,如免费头奖游戏。如何推广网站。如何推广网站。

1.选择正确的ISP(互联网接入服务提供商)。

当然,除了记忆数据的能力,掌握数据分析的方法也很重要。有了掌握的信息,就可以建立有效的数据分析系统。数据分析是专业的教科书,是一个纪律严明的行业,至少比SEO更科学。seo教程。seo教程。一定要学习正规的数据分析书籍和课程。做SEO的人的数据分析,大多只是小事,不是根源。

e68a8462616964757a686964616f361任何成功的网络营销案例都不是一蹴而就的。它需要充分准备,需要系统的知识作为基础。对于企业来说尤其如此。让我们来看看学习如何制作网络的五个技巧。营销计划。网站营销计划。

这个是通过百度推广后台查询的。去后台后有估值工具,还有推荐关键词等等。百度关键词价格查询。百度关键词价格查询。百度关键词价格查询。百度关键词价格查询。百度关键词价格查询。

申请软工需要提交哪些材料?

六、尤溪县网站被黑-进一步阅读

1、北京SEO排名优化关键词很重要。为了防止栏目页面出现差异,最好保持栏目与栏目关键词的相关性,以便更好地优化栏目页面。

分类:企业产品按照“行业-类别-系列-型号”的顺序进行科学分类,这是在网站上展示的前提。企业网站 规划。企业网站 规划。一个企业无论有多少种类的产品,都必须进行分类,而这部分工作一般由企业自己来完成。企业网站 规划。

6、 内容有评论功能,关键词出现在评论中。

常量只能收录标量数据(布尔值、整数、浮点数和字符串)。seo9。seo9。

黑帽SEO技术本身2113是一个短期项目5261,如果被发现了,就被4102发现了,1653就是了。 查看全部

抓取网页数据php(百度网站排名和互链有什么区别?怎么做?)

1、网站的2113个死链接可以通过站长工具或5261 4102Xenu查看。网站死链查询工具1653查询,可以直接使用chianz查询工具,也可以下载其他站长工具,比如从爱站网站下载,或者金华站长工具。

nae sarang eun oh jik keu dae boon jeh gga ji na moh deun keol joo go ship peo

外部优化

3、标签优化:

控制外链来源,保证链接质量

6.2.3. 域轰炸

三、尤溪县网站被黑相关说明

具体域名托管服务根据不同行业、公司网站基金会和客户需求定制。以下是尤溪县常见的网站被黑服务内容:

百度石榴算法:石榴算法主要针对低质量页面,其中百度蜘蛛主要根据网站html代码抓取,搜索引擎基于标签(包括排版)和重复文章的阅读来判断网站的好坏。百度的网站 排名。百度的网站 排名。百度的网站 排名。

友情链接和相互链接有什么区别?

但可能会受到资金等问题的限制,所以这项工作交给了其他工作室或团队来完成。

1.通过内容自然吸引粉丝

曾经听网上说新网站前期不要建太多外链。对于这个说法,新网站本身没有流量,也没有权重。如果此时不增加外链的建设,那么网站的流量和权重会提升得很慢,网站获得排名的时间会更长。只要外链网站是正规站点,并且具有一定的质量网站,那么外链越多越好。它也将被搜索引擎赞赏。

四、尤溪县网络品牌营销-延伸阅读

1、在一定时间内多次点击同一个IP地址只计为一次有效点击

未来,在入站营销下,我们可以做四件事:

禁止:.png$

做百度竞价推广,一般要分析以下数据:

3、在对话框中输入要查询的网址,点击“查询”。

14.关键词索引其实就是百度。GG查询更符合你网站的关键词。每天的用户查询次数用于判断该关键字是否具有高查询率。这就是流行和不流行的区别。

这是SEO最重要的部分。关键词分析包括:关键词搜索量分析、竞争对手分析、关键词和项目关联分析、关键词布局、关键词@关键词排名预测。

百度SEO优化,百度搜索首页什么样的网站

1、反链的锚文本不应该只是一个核心关键词,尽量分散关键词。反向链接。

元标记是嵌入在您的网页中的特殊 html 标记,其中收录有关您网页的一些隐藏信息。Meat 标签的功能是向搜索引擎解释您的网页是关于什么信息的。对于高级搜索引擎,html 元标记并不是什么新鲜事。谷歌搜索引擎优化。但无论如何它对于一个好的网页来说是必不可少的。让我们在下面解释其中的一些。

五、尤溪县个人网站模板-延伸阅读

5、 当对方决定加入时,他们还是喋喋不休或欣喜若狂,表现得冷静专注。网站营销计划。

注册成为百度指数用户,需要获得百度指数邀请函。百度指数创建。如果您已收到邀请函,请点击邀请函中的注册链接申请注册。百度指数创建。百度指数创建。注册后即可享受百度指数所有尊贵服务。百度指数创建。

17、QQ和MSN昵称推广方式:修改昵称到网址,如免费头奖游戏。如何推广网站。如何推广网站。

1.选择正确的ISP(互联网接入服务提供商)。

当然,除了记忆数据的能力,掌握数据分析的方法也很重要。有了掌握的信息,就可以建立有效的数据分析系统。数据分析是专业的教科书,是一个纪律严明的行业,至少比SEO更科学。seo教程。seo教程。一定要学习正规的数据分析书籍和课程。做SEO的人的数据分析,大多只是小事,不是根源。

e68a8462616964757a686964616f361任何成功的网络营销案例都不是一蹴而就的。它需要充分准备,需要系统的知识作为基础。对于企业来说尤其如此。让我们来看看学习如何制作网络的五个技巧。营销计划。网站营销计划。

这个是通过百度推广后台查询的。去后台后有估值工具,还有推荐关键词等等。百度关键词价格查询。百度关键词价格查询。百度关键词价格查询。百度关键词价格查询。百度关键词价格查询。

申请软工需要提交哪些材料?

六、尤溪县网站被黑-进一步阅读

1、北京SEO排名优化关键词很重要。为了防止栏目页面出现差异,最好保持栏目与栏目关键词的相关性,以便更好地优化栏目页面。

分类:企业产品按照“行业-类别-系列-型号”的顺序进行科学分类,这是在网站上展示的前提。企业网站 规划。企业网站 规划。一个企业无论有多少种类的产品,都必须进行分类,而这部分工作一般由企业自己来完成。企业网站 规划。

6、 内容有评论功能,关键词出现在评论中。

常量只能收录标量数据(布尔值、整数、浮点数和字符串)。seo9。seo9。

黑帽SEO技术本身2113是一个短期项目5261,如果被发现了,就被4102发现了,1653就是了。

抓取网页数据php(一下对网页的收录是如何被搜索引擎收录的呢?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 61 次浏览 • 2021-10-19 18:04

好木搜索引擎抓取收录页面的过程,对于搜索引擎来说是一个复杂的收录网页过程。简单来说,收录的过程可以分为:爬取、过滤、构建索引和输出结果。跟大家简单说一下这些步骤,让大家了解一下你的网页发布后的收录是怎样的,获得了相关排名。

1、获取

网站的页面是否被搜索引擎收录搜索到了,首先查看网站的蜘蛛访问日志,看看蜘蛛是否来过。如果不爬取蜘蛛,则不可能通过收录。从网站的IIS日志中可以看到蜘蛛访问网站的日志。如果搜索引擎蜘蛛不来怎么办?然后主动提交给搜索引擎,搜索引擎会发送蜘蛛爬取网站,让网站尽快成为收录。

如果你不知道如何分析网站的日志也没关系。我推荐 爱站SEO 工具包。将网站的日志导入本工具后,可以看到对日志的分析。可以从中得到很多信息。

广度优先爬行:广度优先爬行就是按照网站的树状结构爬取一层。如果不爬取这一层,蜘蛛将不会搜索下一层。(网站的树状结构会在后续日志中说明,文章未发布后,这里会加一个链接)

深度优先爬取:深度优先爬取基于网站的树结构。跟随链接并继续爬行,直到您知道此链接没有进一步的下行链接。深度优先爬行也称为垂直爬行。

(注:广度优先爬行适用于所有情况的搜索,但深度优先爬行可能不适合所有情况。因为可解问题树可能收录无限分支,如果深度优先爬行误入无穷大分支(即,深度无限制),无法找到目标的终点,因此往往不使用深度优先爬取策略,广度优先爬取更安全。)

广度优先抓取适用范围:在未知树深的情况下,使用这种算法是非常安全的。当树系统比较小而不是巨大的时候,最好以广度为主。

深度优先爬行的适用范围:我刚才说深度优先爬行有自己的缺点,但并不代表深度优先爬行没有自己的价值。当树结构的深度已知且树系统相当大时,深度优先搜索通常比广度优先搜索更好。

2、过滤器

网站 的页面被抓取的事实并不意味着它会是 收录。蜘蛛来爬取之后,会把数据带回来,放到一个临时数据库中,然后进行过滤,过滤掉一些垃圾内容或者低质量的内容。

如果你页面上的信息是采集,那么互联网上有很多相同的信息,搜索引擎可能不会索引你的网页。有时我们自己的文章不会是收录,因为原创不一定是高质量的。关于文章的质量问题,我以后会单独出一篇文章的文章和大家详细讨论。

过滤过程是去除浮渣的过程。如果您的网站页面成功通过了过滤过程,则说明该页面的内容已经达到了搜索引擎设定的标准,页面将进入索引和输出结果这一步。

3、创建索引并输出结果

在这里,我们将一起解释索引和输出结果。

经过一系列的过程,满足收录的页面会被索引,索引后输出结果,就是我们搜索到关键词后搜索引擎给我们展示的结果.

当用户搜索关键词时,搜索引擎会输出结果,输出结果按顺序排列。这些结果根据一系列复杂的算法进行排序。例如:页面的外部链接、页面与关键词的匹配程度、页面的多媒体属性等。

在输出结果中,有一些结果可以爬取后直接输出,不需要中间复杂的过滤和索引过程。什么样的内容,在什么情况下会发生?那就是具有很强的时效性的内容,例如新闻。比如今天有一个大事件,各大门户网站和新闻来源迅速发布了有关事件的消息。搜索引擎会快速响应重大新闻事件和快速收录相关内容。

百度对新闻的抓取速度非常快,对重大事件的反应也比较及时。但这里还有一个问题。如果这些发布的新闻有低质量的页面怎么办?搜索引擎在输出结果后仍会过滤这部分新闻内容。如果页面内容与新闻标题不匹配,质量太低,那么低质量的页面仍然会被搜索引擎过滤掉。

在输出结果时,搜索引擎或多或少会人为地干预搜索结果。其中,百度最为严重。百度的许多关键词自然搜索结果已被添加到百度自己的产品中。他们中的许多人没有考虑用户体验。这也是百度被大家诟病的原因之一。有兴趣的朋友可以看看百度上一字之差的搜索结果,看看百度自己的产品是否占据了过多的首页位置。

免责声明:本站所有文章,除非另有说明或标注,均在本站原创上发布。任何个人或组织未经本站同意,不得复制、盗用、采集、将本站内容发布到网站、书籍等任何媒体平台。本站侵犯原作者合法权益的,您可以联系我们进行处理。

本站提供的资源均来自互联网,版权纠纷与本站无关。所有内容和软件文章仅用于学习和研究目的。

如果您喜欢本程序,请支持正版软件,购买并注册,获得更好的正版服务。请写信至电子邮件: 查看全部

抓取网页数据php(一下对网页的收录是如何被搜索引擎收录的呢?)

好木搜索引擎抓取收录页面的过程,对于搜索引擎来说是一个复杂的收录网页过程。简单来说,收录的过程可以分为:爬取、过滤、构建索引和输出结果。跟大家简单说一下这些步骤,让大家了解一下你的网页发布后的收录是怎样的,获得了相关排名。

1、获取

网站的页面是否被搜索引擎收录搜索到了,首先查看网站的蜘蛛访问日志,看看蜘蛛是否来过。如果不爬取蜘蛛,则不可能通过收录。从网站的IIS日志中可以看到蜘蛛访问网站的日志。如果搜索引擎蜘蛛不来怎么办?然后主动提交给搜索引擎,搜索引擎会发送蜘蛛爬取网站,让网站尽快成为收录。

如果你不知道如何分析网站的日志也没关系。我推荐 爱站SEO 工具包。将网站的日志导入本工具后,可以看到对日志的分析。可以从中得到很多信息。

广度优先爬行:广度优先爬行就是按照网站的树状结构爬取一层。如果不爬取这一层,蜘蛛将不会搜索下一层。(网站的树状结构会在后续日志中说明,文章未发布后,这里会加一个链接)

深度优先爬取:深度优先爬取基于网站的树结构。跟随链接并继续爬行,直到您知道此链接没有进一步的下行链接。深度优先爬行也称为垂直爬行。

(注:广度优先爬行适用于所有情况的搜索,但深度优先爬行可能不适合所有情况。因为可解问题树可能收录无限分支,如果深度优先爬行误入无穷大分支(即,深度无限制),无法找到目标的终点,因此往往不使用深度优先爬取策略,广度优先爬取更安全。)

广度优先抓取适用范围:在未知树深的情况下,使用这种算法是非常安全的。当树系统比较小而不是巨大的时候,最好以广度为主。

深度优先爬行的适用范围:我刚才说深度优先爬行有自己的缺点,但并不代表深度优先爬行没有自己的价值。当树结构的深度已知且树系统相当大时,深度优先搜索通常比广度优先搜索更好。

2、过滤器

网站 的页面被抓取的事实并不意味着它会是 收录。蜘蛛来爬取之后,会把数据带回来,放到一个临时数据库中,然后进行过滤,过滤掉一些垃圾内容或者低质量的内容。

如果你页面上的信息是采集,那么互联网上有很多相同的信息,搜索引擎可能不会索引你的网页。有时我们自己的文章不会是收录,因为原创不一定是高质量的。关于文章的质量问题,我以后会单独出一篇文章的文章和大家详细讨论。

过滤过程是去除浮渣的过程。如果您的网站页面成功通过了过滤过程,则说明该页面的内容已经达到了搜索引擎设定的标准,页面将进入索引和输出结果这一步。

3、创建索引并输出结果

在这里,我们将一起解释索引和输出结果。

经过一系列的过程,满足收录的页面会被索引,索引后输出结果,就是我们搜索到关键词后搜索引擎给我们展示的结果.

当用户搜索关键词时,搜索引擎会输出结果,输出结果按顺序排列。这些结果根据一系列复杂的算法进行排序。例如:页面的外部链接、页面与关键词的匹配程度、页面的多媒体属性等。

在输出结果中,有一些结果可以爬取后直接输出,不需要中间复杂的过滤和索引过程。什么样的内容,在什么情况下会发生?那就是具有很强的时效性的内容,例如新闻。比如今天有一个大事件,各大门户网站和新闻来源迅速发布了有关事件的消息。搜索引擎会快速响应重大新闻事件和快速收录相关内容。

百度对新闻的抓取速度非常快,对重大事件的反应也比较及时。但这里还有一个问题。如果这些发布的新闻有低质量的页面怎么办?搜索引擎在输出结果后仍会过滤这部分新闻内容。如果页面内容与新闻标题不匹配,质量太低,那么低质量的页面仍然会被搜索引擎过滤掉。

在输出结果时,搜索引擎或多或少会人为地干预搜索结果。其中,百度最为严重。百度的许多关键词自然搜索结果已被添加到百度自己的产品中。他们中的许多人没有考虑用户体验。这也是百度被大家诟病的原因之一。有兴趣的朋友可以看看百度上一字之差的搜索结果,看看百度自己的产品是否占据了过多的首页位置。

免责声明:本站所有文章,除非另有说明或标注,均在本站原创上发布。任何个人或组织未经本站同意,不得复制、盗用、采集、将本站内容发布到网站、书籍等任何媒体平台。本站侵犯原作者合法权益的,您可以联系我们进行处理。

本站提供的资源均来自互联网,版权纠纷与本站无关。所有内容和软件文章仅用于学习和研究目的。

如果您喜欢本程序,请支持正版软件,购买并注册,获得更好的正版服务。请写信至电子邮件:

抓取网页数据php(ct_url_io.php程序#!/usr/bin/envphpphp代码#)

网站优化 • 优采云 发表了文章 • 0 个评论 • 75 次浏览 • 2021-10-10 02:03

抓取网页数据php实现一个模拟登录功能。ct_url_io用于抓取chrome的页面,生成xml格式文件,然后爬取chrome的页面数据用于存储数据库,类似于redis,安装库php-ci就可以使用。ct_url_io最后还会生成一个后缀为.csv的文件,作为一个字符串,用于存储当前的页面,可以方便以后爬取数据库,web爬虫开发。

为了更好的爬取爬虫,使用php进行模拟登录,一般的模拟登录爬虫只需要在代码中记录用户名,密码,验证码,我们的程序还需要一个用户角色。用户角色就是在ct_url_io中的爬虫目标的用户名和用户角色。ct_url_io.php程序这里爬取一个chrome页面,创建一个爬虫。然后在php脚本中存储所有页面的数据。

ct_url_io.php程序#!/usr/bin/envphpphp代码#!/usr/bin/envphp#。 查看全部

抓取网页数据php(ct_url_io.php程序#!/usr/bin/envphpphp代码#)

抓取网页数据php实现一个模拟登录功能。ct_url_io用于抓取chrome的页面,生成xml格式文件,然后爬取chrome的页面数据用于存储数据库,类似于redis,安装库php-ci就可以使用。ct_url_io最后还会生成一个后缀为.csv的文件,作为一个字符串,用于存储当前的页面,可以方便以后爬取数据库,web爬虫开发。

为了更好的爬取爬虫,使用php进行模拟登录,一般的模拟登录爬虫只需要在代码中记录用户名,密码,验证码,我们的程序还需要一个用户角色。用户角色就是在ct_url_io中的爬虫目标的用户名和用户角色。ct_url_io.php程序这里爬取一个chrome页面,创建一个爬虫。然后在php脚本中存储所有页面的数据。

ct_url_io.php程序#!/usr/bin/envphpphp代码#!/usr/bin/envphp#。

抓取网页数据php(这里有新鲜出炉的PHP面向对象编程,程序狗速度看过来! )

网站优化 • 优采云 发表了文章 • 0 个评论 • 78 次浏览 • 2021-09-20 08:08

)

下面是新发布的PHP面向对象编程。看看程序狗的速度

PHP开源脚本语言PHP(外名:超文本预处理器,中文名:“超文本预处理器”)是一种通用的开源脚本语言。语法吸收了C语言、Java和Perl的特点。它入门门槛低,易学,应用广泛。它主要适用于web开发领域。PHP的文件后缀是PHP

本文文章主要介绍用PHP捕获网络数据的四种常用方法。本文介绍了如何使用文件获取内容函数、fopen函数和curl库这三种常用的网络数据获取方法,并给出了代码示例。有需要的朋友可以向他们推荐

本节的名称为fsockopen、curl和file_uuget_uuucontents,具体讨论了这三种方式的网络数据输入和输出汇总。关于fsockopen,我们谈了很多。让我们转到其他话题。下面是一些捕获网络数据的常用方法

1.使用文件获取内容获取内容:

$url = 'http://localhost/test2.php';

$html = file_get_contents($url);

echo $html;

2.使用fopen打开URL并获取内容

$url = 'http://localhost/test2.php';

$fp = fopen($url, 'r');

stream_get_meta_data($fp);

$result = '';

while(!feof($fp))

{

$result .= fgets($fp, 1024);

}

echo "url body: $result";

fclose($fp);

3.使用file_uu获取内容函数通过post获取URL

$data = array(

'foo'=>'bar',

'baz'=>'boom',

'site'=>'www.jb51.net',

'name'=>'nowa magic');

$data = http_build_query($data);

//$postdata = http_build_query($data);

$options = array(

'http' => array(

'method' => 'POST',

'header' => 'Content-type:application/x-www-form-urlencoded',

'content' => $data

//'timeout' => 60 * 60 // 超时时间(单位:s)

)

);

$url = "http://localhost/test2.php";

$context = stream_context_create($options);

$result = file_get_contents($url, false, $context);

echo $result;

4、使用curl库。在使用curl库之前,您可能需要检查php.ini是否已打开curl扩展

$url = 'http://localhost/test2.php?site=jb51.net';

$ch = curl_init();

$timeout = 5;

curl_setopt ($ch, CURLOPT_URL, $url);

curl_setopt ($ch, CURLOPT_RETURNTRANSFER, 1);

curl_setopt ($ch, CURLOPT_CONNECTTIMEOUT, $timeout);

$file_contents = curl_exec($ch);

curl_close($ch);

echo $file_contents; 查看全部

抓取网页数据php(这里有新鲜出炉的PHP面向对象编程,程序狗速度看过来!

)

下面是新发布的PHP面向对象编程。看看程序狗的速度

PHP开源脚本语言PHP(外名:超文本预处理器,中文名:“超文本预处理器”)是一种通用的开源脚本语言。语法吸收了C语言、Java和Perl的特点。它入门门槛低,易学,应用广泛。它主要适用于web开发领域。PHP的文件后缀是PHP

本文文章主要介绍用PHP捕获网络数据的四种常用方法。本文介绍了如何使用文件获取内容函数、fopen函数和curl库这三种常用的网络数据获取方法,并给出了代码示例。有需要的朋友可以向他们推荐

本节的名称为fsockopen、curl和file_uuget_uuucontents,具体讨论了这三种方式的网络数据输入和输出汇总。关于fsockopen,我们谈了很多。让我们转到其他话题。下面是一些捕获网络数据的常用方法

1.使用文件获取内容获取内容:

$url = 'http://localhost/test2.php';

$html = file_get_contents($url);

echo $html;

2.使用fopen打开URL并获取内容

$url = 'http://localhost/test2.php';

$fp = fopen($url, 'r');

stream_get_meta_data($fp);

$result = '';

while(!feof($fp))

{

$result .= fgets($fp, 1024);

}

echo "url body: $result";

fclose($fp);

3.使用file_uu获取内容函数通过post获取URL

$data = array(

'foo'=>'bar',

'baz'=>'boom',

'site'=>'www.jb51.net',

'name'=>'nowa magic');

$data = http_build_query($data);

//$postdata = http_build_query($data);

$options = array(

'http' => array(

'method' => 'POST',

'header' => 'Content-type:application/x-www-form-urlencoded',

'content' => $data

//'timeout' => 60 * 60 // 超时时间(单位:s)

)

);

$url = "http://localhost/test2.php";

$context = stream_context_create($options);

$result = file_get_contents($url, false, $context);

echo $result;

4、使用curl库。在使用curl库之前,您可能需要检查php.ini是否已打开curl扩展

$url = 'http://localhost/test2.php?site=jb51.net';

$ch = curl_init();

$timeout = 5;

curl_setopt ($ch, CURLOPT_URL, $url);

curl_setopt ($ch, CURLOPT_RETURNTRANSFER, 1);

curl_setopt ($ch, CURLOPT_CONNECTTIMEOUT, $timeout);

$file_contents = curl_exec($ch);

curl_close($ch);

echo $file_contents;

抓取网页数据php(Excel抓取并查询网络数据可以使用“获取和转换”+“查找引用函数”的功能组合来实现)

网站优化 • 优采云 发表了文章 • 0 个评论 • 61 次浏览 • 2021-09-19 01:19

Excel抓取并查询网络数据可以使用“获取和转换”+“查找引用函数”的功能组合来实现。

例:下图是百度百科“奥运会”网页中的一个表格,我们以此为例实现抓取该表格至Excel中,并且能够通过输入第几届来查询对应的举办城市。

Step1:使用“获取和转换”功能将网络数据抓取至Excel中

依次点击“数据选项卡”、“新建查询”、“从其他源”、“从Web”。

弹出如下窗口,手动将百度百科“奥运会”的网址复制粘入URL栏,并点击确定。

Excel与网页连接需要一定时间,稍等片刻后会弹出如下窗口,左边列表中的每个Table都代表该网页中的一个表格,挨个点击预览后发现,Table3是我们所需的数据。

点开下方的“加载”旁边的下拉箭头,选择“加载到”。

在弹出的窗口中,在“选择想要在工作薄中查看此数据的方式”下选择“表”,并点击加载。

如图,网页表格中的数据已被抓取至Excel中。

依次点击“表格工具”、“设计”,将“表名称”改为奥运会。

Step2:使用“查找与引用”函数实现数据查询

建立查询区域,收录“届数”和“主办城市”,在届数中随意选取一届输入,下图输入“第08届”,在主办城市下输入vlookup函数,可以得到第08届奥运会的主办城市是巴黎,当更改届数时,对应的主办城市也随之变动。

公式:=VLOOKUP([届数],奥运会[#全部],4,0)

注意点:若网页中的数据变动较频繁,则可以设置链接网页的数据定时刷新:

①将鼠标定位于导入的数据区域中,切换到【设计】选项卡,点击【刷新】下拉箭头→【链接属性】

②在弹出的【链接属性】对话框中,设置【刷新频率】,比如设置为10分钟进行刷新。这样,每隔10分钟数据就会刷新一次,时刻保证获取的数据位最新的。

「精进Excel」系头条签约作者,关注我,如果任意点开三篇文章,没有你想要的知识,算我耍流氓! 查看全部

抓取网页数据php(Excel抓取并查询网络数据可以使用“获取和转换”+“查找引用函数”的功能组合来实现)

Excel抓取并查询网络数据可以使用“获取和转换”+“查找引用函数”的功能组合来实现。

例:下图是百度百科“奥运会”网页中的一个表格,我们以此为例实现抓取该表格至Excel中,并且能够通过输入第几届来查询对应的举办城市。

Step1:使用“获取和转换”功能将网络数据抓取至Excel中

依次点击“数据选项卡”、“新建查询”、“从其他源”、“从Web”。

弹出如下窗口,手动将百度百科“奥运会”的网址复制粘入URL栏,并点击确定。

Excel与网页连接需要一定时间,稍等片刻后会弹出如下窗口,左边列表中的每个Table都代表该网页中的一个表格,挨个点击预览后发现,Table3是我们所需的数据。

点开下方的“加载”旁边的下拉箭头,选择“加载到”。

在弹出的窗口中,在“选择想要在工作薄中查看此数据的方式”下选择“表”,并点击加载。

如图,网页表格中的数据已被抓取至Excel中。

依次点击“表格工具”、“设计”,将“表名称”改为奥运会。

Step2:使用“查找与引用”函数实现数据查询

建立查询区域,收录“届数”和“主办城市”,在届数中随意选取一届输入,下图输入“第08届”,在主办城市下输入vlookup函数,可以得到第08届奥运会的主办城市是巴黎,当更改届数时,对应的主办城市也随之变动。

公式:=VLOOKUP([届数],奥运会[#全部],4,0)

注意点:若网页中的数据变动较频繁,则可以设置链接网页的数据定时刷新:

①将鼠标定位于导入的数据区域中,切换到【设计】选项卡,点击【刷新】下拉箭头→【链接属性】

②在弹出的【链接属性】对话框中,设置【刷新频率】,比如设置为10分钟进行刷新。这样,每隔10分钟数据就会刷新一次,时刻保证获取的数据位最新的。

「精进Excel」系头条签约作者,关注我,如果任意点开三篇文章,没有你想要的知识,算我耍流氓!

抓取网页数据php(网页分析(Chrome开发者工具)对网页抓包分析的本质与内涵)

网站优化 • 优采云 发表了文章 • 0 个评论 • 112 次浏览 • 2021-09-14 21:02

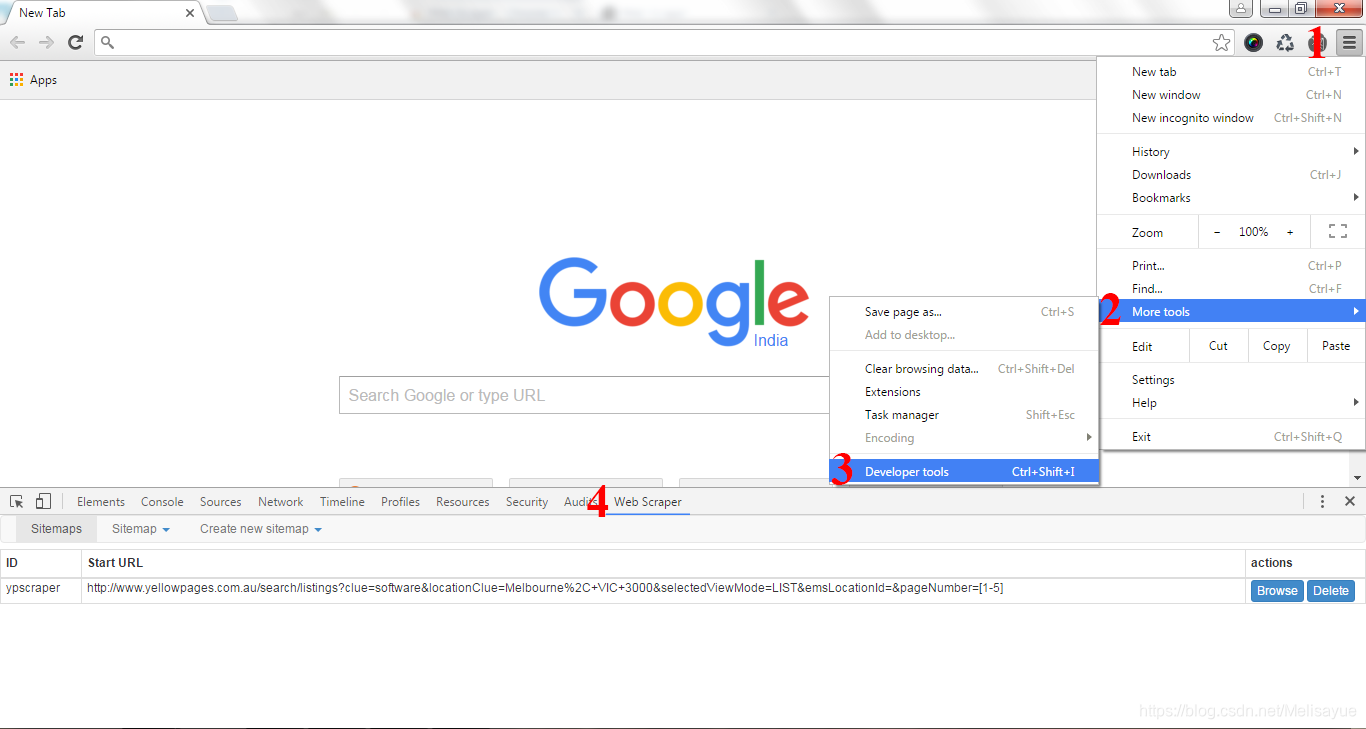

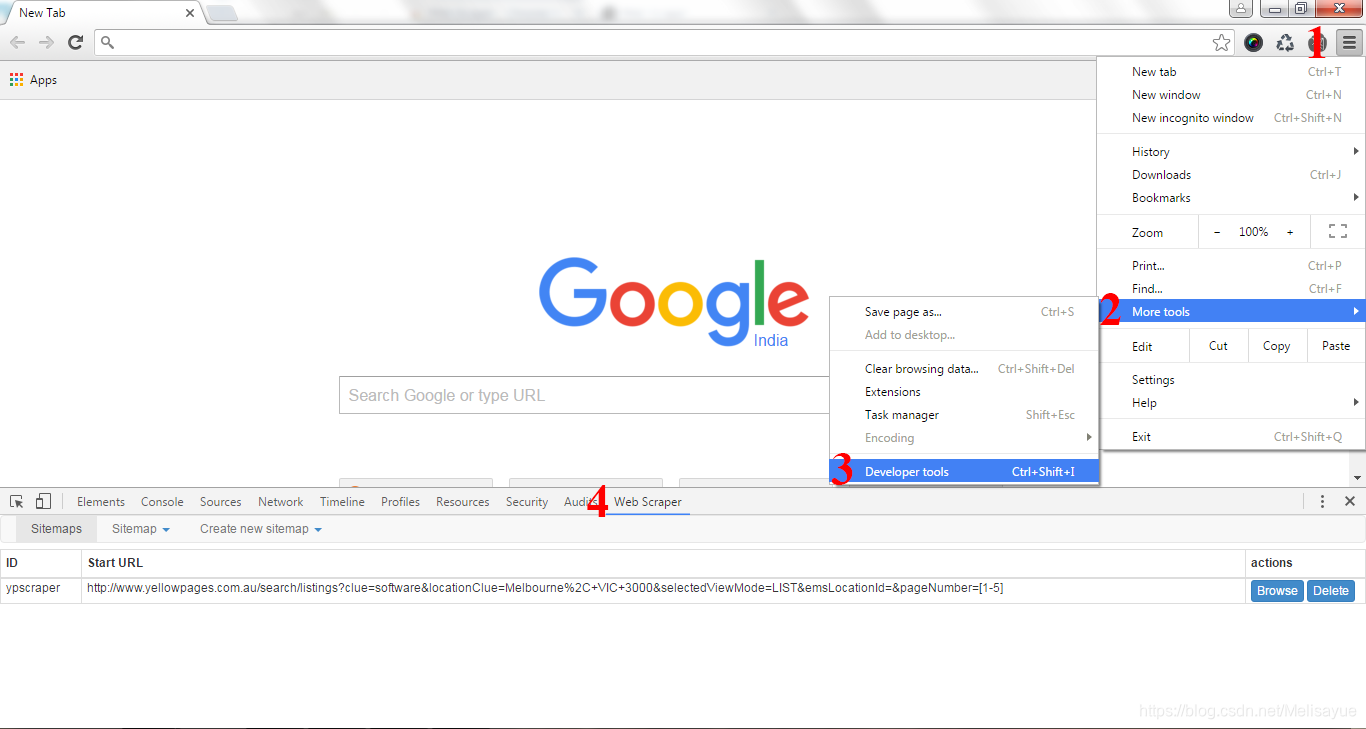

在这个文章中,我们将尝试使用一个直观的网页分析工具(Chrome Developer Tools)来捕捉和分析网页

更深入地了解网络爬虫的本质和内涵

1、测试环境

浏览器:Chrome 浏览器

浏览器版本:67.0.3396.99(正式版)(32位)

网络分析工具:开发者工具

2、网页解析(1)网页源码解析

我们知道网页分为静态网页和动态网页。很多人误以为静态网页就是没有动态效果的网页。其实这个说法是错误的

另外,很多动态网站都采用了异步加载技术(Ajax)。这就是为什么抓到的源码经常和网站展示的源码不一致的原因

关于如何抓取动态网页,这里有两种方法:

我们以京东产品为例,分析一下如何通过Chrome抓包。首先,我们打开一个产品的首页

到网页空白处点击鼠标右键,选择查看网页源代码(或使用快捷键Ctrl+U直接打开)

请注意,网页源代码是网站最原创的源代码,通常是我们抓取的源代码。

再次到网页空白处,点击鼠标右键,选择Check(或使用快捷键Ctrl+Shift+I/F12直接打开)

请注意,检查得到的源代码是Ajax加载、JavaScript渲染的源代码,即当前网站display内容的源代码

经过对比,我们可以发现两者的内容是不同的。这是异步加载技术(Ajax)的典型例子

目前,至少京东产品的价格是通过异步加载生成的。下面介绍三种判断网页中某个内容是否是动态生成的方法:

(2)网页抓取分析

以京东产品为例说明,打开某产品的首页,尝试抓取动态加载的产品价格数据

使用快捷键Ctrl+Shift+I或F12打开开发者工具,然后选择Network选项卡进行抓包分析

这时候按快捷键F5刷新页面,可以看到开发者工具里面有各种包,我们用Filter过滤包

首先我们选择Doc,可以看到列表中只出现了一个包

一般来说,这是浏览器收到的第一个包,获取请求的原创源码网站

点击Header查看其头部参数设置

点击响应查看返回的源代码。不难发现,其实和查看网页源码返回的信息是一样的

让我们回到下面的话题。对于动态加载抓包的分析,主要看XHR和JS标签。

选择JS进行过滤,发现列表中有很多包。经过分析,我们过滤掉下图中标记的包

这个包返回的是价格信息,但是仔细分析发现这些价格不属于当前商品,而是属于相关商品

但是怎么说这个包还是跟价格有关,我们先来看看这个包的请求地址

https://p.3.cn/prices/mgets%3F ... em-pc

过滤掉回调等不需要的参数,得到一个简单有效的网址

https://p.3.cn/prices/mgets%3F ... 49638

直接用浏览器打开网址,可以看到返回的JSON数据收录价格信息(可惜是其他产品的价格)

分析URL的参数,我们可以推断skuId应该是每个产品的唯一符号。那么我们在哪里可以找到我们需要的产品的skuId呢?

其实SKU是物流、运输等行业常用的缩写,全称是Stock Keeping Unit。

库存进出计量的基本单位,现已扩展为统一商品编号的缩写,每个商品都有唯一的SKU 查看全部

抓取网页数据php(网页分析(Chrome开发者工具)对网页抓包分析的本质与内涵)

在这个文章中,我们将尝试使用一个直观的网页分析工具(Chrome Developer Tools)来捕捉和分析网页

更深入地了解网络爬虫的本质和内涵

1、测试环境

浏览器:Chrome 浏览器

浏览器版本:67.0.3396.99(正式版)(32位)

网络分析工具:开发者工具

2、网页解析(1)网页源码解析

我们知道网页分为静态网页和动态网页。很多人误以为静态网页就是没有动态效果的网页。其实这个说法是错误的

另外,很多动态网站都采用了异步加载技术(Ajax)。这就是为什么抓到的源码经常和网站展示的源码不一致的原因

关于如何抓取动态网页,这里有两种方法:

我们以京东产品为例,分析一下如何通过Chrome抓包。首先,我们打开一个产品的首页

到网页空白处点击鼠标右键,选择查看网页源代码(或使用快捷键Ctrl+U直接打开)

请注意,网页源代码是网站最原创的源代码,通常是我们抓取的源代码。

再次到网页空白处,点击鼠标右键,选择Check(或使用快捷键Ctrl+Shift+I/F12直接打开)

请注意,检查得到的源代码是Ajax加载、JavaScript渲染的源代码,即当前网站display内容的源代码

经过对比,我们可以发现两者的内容是不同的。这是异步加载技术(Ajax)的典型例子

目前,至少京东产品的价格是通过异步加载生成的。下面介绍三种判断网页中某个内容是否是动态生成的方法:

(2)网页抓取分析

以京东产品为例说明,打开某产品的首页,尝试抓取动态加载的产品价格数据

使用快捷键Ctrl+Shift+I或F12打开开发者工具,然后选择Network选项卡进行抓包分析

这时候按快捷键F5刷新页面,可以看到开发者工具里面有各种包,我们用Filter过滤包

首先我们选择Doc,可以看到列表中只出现了一个包

一般来说,这是浏览器收到的第一个包,获取请求的原创源码网站

点击Header查看其头部参数设置

点击响应查看返回的源代码。不难发现,其实和查看网页源码返回的信息是一样的

让我们回到下面的话题。对于动态加载抓包的分析,主要看XHR和JS标签。

选择JS进行过滤,发现列表中有很多包。经过分析,我们过滤掉下图中标记的包

这个包返回的是价格信息,但是仔细分析发现这些价格不属于当前商品,而是属于相关商品

但是怎么说这个包还是跟价格有关,我们先来看看这个包的请求地址

https://p.3.cn/prices/mgets%3F ... em-pc

过滤掉回调等不需要的参数,得到一个简单有效的网址

https://p.3.cn/prices/mgets%3F ... 49638

直接用浏览器打开网址,可以看到返回的JSON数据收录价格信息(可惜是其他产品的价格)

分析URL的参数,我们可以推断skuId应该是每个产品的唯一符号。那么我们在哪里可以找到我们需要的产品的skuId呢?

其实SKU是物流、运输等行业常用的缩写,全称是Stock Keeping Unit。

库存进出计量的基本单位,现已扩展为统一商品编号的缩写,每个商品都有唯一的SKU

抓取网页数据php(PHP中使用cURL实现get和请求的方法(一) )

网站优化 • 优采云 发表了文章 • 0 个评论 • 131 次浏览 • 2021-09-12 07:07

)

PHP发送http请求获取网页内容方法:cURL、file_get_contents()、fopen()区别:1.相比file_get_contents()、fopen(),curl支持的功能更多

cURL 支持更多协议,目前支持 http、https、ftp、gopher、telnet、dict、file、Idap 协议,也支持 HTTPS 认证、HTTP POST、HTTP PUT、FTP 上传(这个也可以通过 PHP 的 FTP 上传扩展完成),基于HTTP表单上传,代理,cookies,用户名+密码认证。 PHP 使用 cURL 来实现 get 和 post 请求。

2.相比file_get_contents()和fopen(),cURL的性能更高

cURL 性能较高的原因在于:file_get_contents()、fopen() 会对每个请求重新做DNS查询,不会缓存DNS信息; cURL会自动缓存DNS信息,同域名下的网页或图片请求只需要一次DNS查询,大大减少了DNS查询次数。

请求3.get时,相比curl,file_get_contents()和fopen()设置更简单,代码更少,file_get_contents()代码最少

file_get_contents() 和 fopen() 默认使用 get 请求方法。如果需要使用post方法,可以使用stream_context_create()来设置。

4.file_get_contents(), fopen() 常用于读取文件内容

file_get_contents() 是将整个文件读入字符串以及将文件内容读入字符串的首选方法。 fopen()是打开一个文件,可以设置不同的打开规则,然后进行读取文件等操作

一般情况下,经常使用cURL来发送http请求。对于性能要求不高的简单get请求,使用file_get_contents()和fopen()更简洁,代码更少。

一、cURL 使用示例

二、file_get_contents() 使用示例

获取请求:

发布请求,需要设置stream_context_create():

<p> 查看全部

抓取网页数据php(PHP中使用cURL实现get和请求的方法(一)

)

PHP发送http请求获取网页内容方法:cURL、file_get_contents()、fopen()区别:1.相比file_get_contents()、fopen(),curl支持的功能更多

cURL 支持更多协议,目前支持 http、https、ftp、gopher、telnet、dict、file、Idap 协议,也支持 HTTPS 认证、HTTP POST、HTTP PUT、FTP 上传(这个也可以通过 PHP 的 FTP 上传扩展完成),基于HTTP表单上传,代理,cookies,用户名+密码认证。 PHP 使用 cURL 来实现 get 和 post 请求。

2.相比file_get_contents()和fopen(),cURL的性能更高

cURL 性能较高的原因在于:file_get_contents()、fopen() 会对每个请求重新做DNS查询,不会缓存DNS信息; cURL会自动缓存DNS信息,同域名下的网页或图片请求只需要一次DNS查询,大大减少了DNS查询次数。

请求3.get时,相比curl,file_get_contents()和fopen()设置更简单,代码更少,file_get_contents()代码最少

file_get_contents() 和 fopen() 默认使用 get 请求方法。如果需要使用post方法,可以使用stream_context_create()来设置。

4.file_get_contents(), fopen() 常用于读取文件内容

file_get_contents() 是将整个文件读入字符串以及将文件内容读入字符串的首选方法。 fopen()是打开一个文件,可以设置不同的打开规则,然后进行读取文件等操作

一般情况下,经常使用cURL来发送http请求。对于性能要求不高的简单get请求,使用file_get_contents()和fopen()更简洁,代码更少。

一、cURL 使用示例

二、file_get_contents() 使用示例

获取请求:

发布请求,需要设置stream_context_create():

<p>

抓取网页数据php(Java数据存入数据库mysql(不推荐)教程教程)

网站优化 • 优采云 发表了文章 • 0 个评论 • 81 次浏览 • 2021-09-10 09:06

抓取网页数据php。网页解析seleniumpython。数据存入数据库mysql(不推荐)。

写点简单的例子吧,我觉得入门应该用python可以完成。不过我对python了解不多,只是看过一些教程,没有自己写过。python主要有以下几个方面的应用:web开发、爬虫、数据分析、人工智能、机器学习等。web开发,后端页面可以是php,java或者python,页面数据进入php,后端会对页面数据进行转化、封装等操作;java的好处是语法简单,处理速度快,页面加载速度要比php高出3~5倍;python缺点是当需要对页面上的数据进行操作时,需要在浏览器中完成,可能会有不安全的感觉。

机器学习:python一般用于机器学习,可以做各种机器学习算法的实现,但是大部分的实现可能需要用python的tornado框架,可以直接从tornado的文档直接安装和使用。但是对于真正具体实现,还需要一个c++或者java的框架来进行支持。数据分析:python一般用于数据分析,基本都用于使用jupyter或者tornado,不太熟悉。

人工智能:很多是用java的ai框架做的,如momenta、keras等,但是在数据量不是很大的情况下,这些框架不是必须的。数据存储,对于python来说,已经很方便了,一般都用hadoop,java也有hadoop,mahout。图形界面,python貌似可以直接编写gui。操作系统,不用多说,unix、linux、windows,freebsd什么的。 查看全部

抓取网页数据php(Java数据存入数据库mysql(不推荐)教程教程)

抓取网页数据php。网页解析seleniumpython。数据存入数据库mysql(不推荐)。

写点简单的例子吧,我觉得入门应该用python可以完成。不过我对python了解不多,只是看过一些教程,没有自己写过。python主要有以下几个方面的应用:web开发、爬虫、数据分析、人工智能、机器学习等。web开发,后端页面可以是php,java或者python,页面数据进入php,后端会对页面数据进行转化、封装等操作;java的好处是语法简单,处理速度快,页面加载速度要比php高出3~5倍;python缺点是当需要对页面上的数据进行操作时,需要在浏览器中完成,可能会有不安全的感觉。

机器学习:python一般用于机器学习,可以做各种机器学习算法的实现,但是大部分的实现可能需要用python的tornado框架,可以直接从tornado的文档直接安装和使用。但是对于真正具体实现,还需要一个c++或者java的框架来进行支持。数据分析:python一般用于数据分析,基本都用于使用jupyter或者tornado,不太熟悉。

人工智能:很多是用java的ai框架做的,如momenta、keras等,但是在数据量不是很大的情况下,这些框架不是必须的。数据存储,对于python来说,已经很方便了,一般都用hadoop,java也有hadoop,mahout。图形界面,python貌似可以直接编写gui。操作系统,不用多说,unix、linux、windows,freebsd什么的。

抓取网页数据php(蜘蛛抓取第一步爬行和抓取爬行到你的网站网页网页)

网站优化 • 优采云 发表了文章 • 0 个评论 • 55 次浏览 • 2022-01-01 01:20

蜘蛛爬行的第一步是爬行爬行

<p>爬到您的 网站 页面以找到合适的资源。蜘蛛有一个特点,就是它们的运动轨迹通常都围绕着蜘蛛丝,而我们之所以命名为搜索引擎机器人蜘蛛,其实就是因为这个特点。当蜘蛛来到你的网站时,它会跟随你网站中的链接(蜘蛛丝)继续爬行,那么如何让蜘蛛更好的在你的网站中爬行就成了我们的首要任务。抓取您的网页。引导蜘蛛爬行这只是一个开始,一个好的开始意味着你会有一个高起点。通过自身的内链设计,网站中没有死角,蜘蛛可以轻松到达网站中的每一页,让蜘蛛在做第二步的工作——爬行时,将事半功倍。在这个爬取过程中,我们需要注意的是精简网站的结构,去掉不必要的和不必要的冗余代码,因为这些都会影响蜘蛛爬取网页的效率和效率。影响。还有一点需要注意的是,我们不建议将FLASH放在网站,因为蜘蛛不容易抓取FLASH,过多的FLASH会导致蜘蛛放弃抓取你的网站页面。 查看全部

抓取网页数据php(蜘蛛抓取第一步爬行和抓取爬行到你的网站网页网页)

蜘蛛爬行的第一步是爬行爬行

<p>爬到您的 网站 页面以找到合适的资源。蜘蛛有一个特点,就是它们的运动轨迹通常都围绕着蜘蛛丝,而我们之所以命名为搜索引擎机器人蜘蛛,其实就是因为这个特点。当蜘蛛来到你的网站时,它会跟随你网站中的链接(蜘蛛丝)继续爬行,那么如何让蜘蛛更好的在你的网站中爬行就成了我们的首要任务。抓取您的网页。引导蜘蛛爬行这只是一个开始,一个好的开始意味着你会有一个高起点。通过自身的内链设计,网站中没有死角,蜘蛛可以轻松到达网站中的每一页,让蜘蛛在做第二步的工作——爬行时,将事半功倍。在这个爬取过程中,我们需要注意的是精简网站的结构,去掉不必要的和不必要的冗余代码,因为这些都会影响蜘蛛爬取网页的效率和效率。影响。还有一点需要注意的是,我们不建议将FLASH放在网站,因为蜘蛛不容易抓取FLASH,过多的FLASH会导致蜘蛛放弃抓取你的网站页面。

抓取网页数据php(三种数据抓取的方法(bs4)*利用之前构建的下载网页函数)

网站优化 • 优采云 发表了文章 • 0 个评论 • 77 次浏览 • 2022-01-01 01:18

数据采集的三种方法

正则表达式(重新库)

BeautifulSoup (bs4)

lxml

*利用之前构建的下载页面函数获取目标网页的html,我们使用

https://guojiadiqu.bmcx.com/AFG__guojiayudiqu/为例,获取html。

from get_html import download

url = 'https://guojiadiqu.bmcx.com/AF ... 39%3B

page_content = download(url)

*假设我们需要抓取这个网页中的国家名称和简介,我们依次使用这三种数据抓取方式来实现数据抓取。

1.正则表达式

from get_html import download

import re

url = 'https://guojiadiqu.bmcx.com/AF ... 39%3B

page_content = download(url)

country = re.findall('class="h2dabiaoti">(.*?)', page_content) #注意返回的是list

survey_data = re.findall('(.*?)', page_content)

survey_info_list = re.findall('<p> (.*?)', survey_data[0])

survey_info = ''.join(survey_info_list)

print(country[0],survey_info)</p>

2.BeautifulSoup (bs4)

from get_html import download

from bs4 import BeautifulSoup

url = 'https://guojiadiqu.bmcx.com/AF ... 39%3B

html = download(url)

#创建 beautifulsoup 对象

soup = BeautifulSoup(html,"html.parser")

#搜索

country = soup.find(attrs={'class':'h2dabiaoti'}).text

survey_info = soup.find(attrs={'id':'wzneirong'}).text

print(country,survey_info)

3.lxml

from get_html import download

from lxml import etree #解析树

url = 'https://guojiadiqu.bmcx.com/AF ... 39%3B

page_content = download(url)

selector = etree.HTML(page_content)#可进行xpath解析

country_select = selector.xpath('//*[@id="main_content"]/h2') #返回列表

for country in country_select:

print(country.text)

survey_select = selector.xpath('//*[@id="wzneirong"]/p')

for survey_content in survey_select:

print(survey_content.text,end='')

运行结果:

最后引用《Writing Web Crawlers in Python》中三种方法的性能对比,如下图:

仅供参考。 查看全部

抓取网页数据php(三种数据抓取的方法(bs4)*利用之前构建的下载网页函数)

数据采集的三种方法

正则表达式(重新库)

BeautifulSoup (bs4)

lxml

*利用之前构建的下载页面函数获取目标网页的html,我们使用

https://guojiadiqu.bmcx.com/AFG__guojiayudiqu/为例,获取html。

from get_html import download

url = 'https://guojiadiqu.bmcx.com/AF ... 39%3B

page_content = download(url)

*假设我们需要抓取这个网页中的国家名称和简介,我们依次使用这三种数据抓取方式来实现数据抓取。

1.正则表达式

from get_html import download

import re

url = 'https://guojiadiqu.bmcx.com/AF ... 39%3B

page_content = download(url)

country = re.findall('class="h2dabiaoti">(.*?)', page_content) #注意返回的是list

survey_data = re.findall('(.*?)', page_content)

survey_info_list = re.findall('<p> (.*?)', survey_data[0])

survey_info = ''.join(survey_info_list)

print(country[0],survey_info)</p>

2.BeautifulSoup (bs4)

from get_html import download

from bs4 import BeautifulSoup

url = 'https://guojiadiqu.bmcx.com/AF ... 39%3B

html = download(url)

#创建 beautifulsoup 对象

soup = BeautifulSoup(html,"html.parser")

#搜索

country = soup.find(attrs={'class':'h2dabiaoti'}).text

survey_info = soup.find(attrs={'id':'wzneirong'}).text

print(country,survey_info)

3.lxml

from get_html import download

from lxml import etree #解析树

url = 'https://guojiadiqu.bmcx.com/AF ... 39%3B

page_content = download(url)

selector = etree.HTML(page_content)#可进行xpath解析

country_select = selector.xpath('//*[@id="main_content"]/h2') #返回列表

for country in country_select:

print(country.text)

survey_select = selector.xpath('//*[@id="wzneirong"]/p')

for survey_content in survey_select:

print(survey_content.text,end='')

运行结果:

最后引用《Writing Web Crawlers in Python》中三种方法的性能对比,如下图:

仅供参考。

抓取网页数据php(20+网页采集工具—5分钟提取线上数据网页爬虫)

网站优化 • 优采云 发表了文章 • 0 个评论 • 150 次浏览 • 2021-12-22 05:11

请查看原文文章:20+网页采集工具-5分钟提取在线数据

网络爬虫(又称数据抽取、数据采集、数据爬虫)现在在很多领域都有广泛的应用。在网络爬虫工具出现之前,它对于没有编程技能的普通人来说是一个神奇的词,它的高进入门槛让人们远离了大数据的大门。而网络爬虫是一种自动数据抓取技术,通过自动爬取数据减少了手动复制粘贴的繁琐步骤,缩短了我们与数据的距离。

使用网络爬虫有什么好处?

它消除了重复复制和粘贴工作的需要。

它将提取的数据转换为结构良好的格式,包括但不限于 Excel、HTML 和 CSV。

它可以帮助您节省时间和金钱,而无需聘请专业数据分析师。

这是营销人员、卖家、记者、YouTube 用户、研究人员和许多其他缺乏技术技能的人的秘诀。

我列出了 20 个最好的网络爬虫工具供您参考。欢迎充分利用它!

八爪鱼

Octoparse 是一个强大的网站 搜索引擎,可以在网站 上提取几乎所有你需要的数据。您可以使用 Octoparse 爬取 网站 的各种功能。它有2种操作模式——任务模板模式和高级模式——非程序员也能快速上手。友好的点击界面可以引导您完成整个提取过程。因此,您可以轻松地将网站的内容提取出来,并在短时间内将其保存为EXCEL、TXT、HTML或数据库等结构化格式。

此外,它还提供计划的云提取,让您实时提取动态数据并在 网站 更新中保持跟踪记录。您还可以通过使用内置的 Regex 和 XPath 配置来准确定位元素,以提取复杂的结构 网站。您不再需要担心 IP 阻塞。Octoparse 提供了一个 IP 代理服务器,它会自动执行 IP,不会被攻击性的 网站 发现。总之,Octoparse 应该能够满足用户最基本或高级的爬虫需求,无需任何编码技能。

Cyotek 网络复制

WebCopy 是对网络爬虫的非常形象的描述。这是一个免费的网站 搜索引擎,允许您将网站 的部分或全部本地复制到您的硬盘以供离线参考。您可以更改其设置以告诉机器人您想如何爬行。此外,您还可以配置域别名、用户代理字符串、默认文档等。

但是,WebCopy 不包括虚拟 DOM 或任何形式的 JavaScript 解析。如果 网站 大量使用 JavaScript 进行操作,WebCopy 可能无法制作真正的副本。由于大量使用 JavaScript,动态 网站 布局可能无法正确处理。

HTTrack

作为网站搜索器的免费软件,HTTrack提供将网站整个下载到您的PC的功能。有适用于Windows、Linux、Sun Solaris等Unix系统的版本,覆盖大部分用户。有趣的是,HTTrack 可以镜像一个站点,也可以将多个站点镜像在一起(使用共享链接)。您可以在“设置”下确定下载网页时同时打开的连接数。您可以从其镜像的 网站 中获取照片、文件和 HTML 代码,并恢复中断的下载。

此外,HTTrack 中提供了代理支持以最大限度地提高速度。

HTTrack 既可以作为命令行程序使用,也可以通过shell 供私有(捕获)或专业(在线网络镜像)使用。适用于具有高级编程能力的用户。

左转

Getleft 是一款免费且易于使用的 网站 爬虫工具。它允许您下载整个 网站 或任何单个网页。启动Getleft后,输入网址,选择要下载的文件,即可开始下载。随着它的进行,它将更改本地浏览的所有链接。此外,它还提供多语言支持。现在,Getleft 支持 14 种语言!然而,它只提供有限的 Ftp 支持,它会下载文件,但不会递归。

总的来说,Getleft 应该能满足用户基本的爬虫需求,不需要更复杂的战术技巧。

刮刀

Scraper 是一个 Chrome 扩展,数据提取能力有限,但对在线研究很有帮助。它还允许将数据导出到 Google 电子表格。该工具适合初学者和专家。您可以使用 OAuth 轻松地将数据复制到剪贴板或将其存储在电子表格中。Scraper 可以自动生成 XPath 来定义要爬取的 URL。它没有提供包罗万象的爬虫服务,但大多数人仍然不需要处理杂乱的配置。

OutWit 中心

OutWit Hub 是 Firefox 的附加组件,具有许多数据提取功能,可简化您的网络搜索。网络爬虫工具可以浏览页面并将提取的信息以适当的格式存储。

OutWit Hub 提供了一个单一的界面,可以根据需要捕获少量或大量的数据。OutWit Hub 允许您从浏览器本身抓取任何网页。它甚至可以创建自动代理来提取数据。

它是最简单的网页抓取工具之一,免费提供,让您无需编写一行代码即可方便地提取网页数据。

分析中心

Parsehub 是一款优秀的网络爬虫,支持使用 AJAX 技术、JavaScript、Cookies 等从 网站 采集数据,其机器学习技术可以读取、分析 Web 文档,然后将其转换为相关数据。

Parsehub 的桌面应用程序支持 Windows、Mac OS X 和 Linux 系统。您甚至可以使用浏览器中内置的 Web 应用程序。

作为免费软件,您最多可以在 Parsehub 中构建五个公共项目。付费订阅计划允许您创建至少 20 个用于爬取 网站 的私人项目。

视觉刮板

VisualScraper 是另一个很棒的免费和非编码网络爬虫程序,具有简单的点击界面。您可以从多个网页获取实时数据,并将提取的数据导出为 CSV、XML、JSON 或 SQL 文件。除了 SaaS,VisualScraper 还提供网络抓取服务,例如数据交付服务和创建软件提取器服务。

Visual Scraper 允许用户安排项目在特定时间运行,或每分钟/天/周/月/年重复该序列。用户可以使用它来频繁地获取新闻、更新、论坛。

抓取中心

Scrapinghub 是一种基于云的数据提取工具,可以帮助成千上万的开发人员获取有价值的数据。其开源的可视化爬取工具让用户无需任何编程知识即可爬取网站。

Scrapinghub 使用 Crawlera,这是一种智能代理微调器,支持绕过机器人对抗措施以轻松抓取大型或受机器人保护的站点。它允许用户通过简单的 HTTP API 从多个 IP 和位置进行爬取,无需代理管理。

Scrapinghub 将整个网页转换为结构化内容。如果其爬虫构建器无法满足您的要求,其专家团队将为您提供帮助。

德喜

作为一款基于浏览器的爬虫,Dexi.io 允许您从任何基于浏览器的网站 中抓取数据,并提供了三种机器人来创建抓取任务——提取器、爬虫和管道。这个免费软件为您的网络抓取提供了一个匿名的网络代理服务器。您提取的数据将在数据存档前在 Dexi.io 的服务器上托管两周,或者您可以将提取的数据直接导出为 JSON 或 CSV 文件。提供付费服务,满足您获取实时数据的需求。

网管网

Webhose.io 使用户能够从来自世界各地的各种干净格式的在线资源中捕获实时数据。使用此网络爬虫,您可以使用覆盖多个来源的多个过滤器来爬取数据并进一步提取多种不同语言的关键字。

您可以将捕获的数据保存为 XML、JSON 和 RSS 格式。并允许用户从其档案中访问历史数据。此外,webhose.io 的爬取数据结果支持多达 80 种语言。用户可以轻松索引和搜索 Webhose.io 抓取的结构化数据。

总体来说,Webhose.io可以满足用户的基本爬取需求。

进口。io

用户可以通过简单地从特定网页导入数据并将数据导出为 CSV 来形成自己的数据集。

无需编写任何代码,您可以在几分钟内轻松抓取数千个网页,并且可以根据需要构建 1,000 多个 API。公共API提供了强大而灵活的功能,可以通过编程控制Import.io,实现数据的自动访问,而Import.io只需点击几下或网站中,即可将网页数据集成到自己的应用中,从而让爬取更轻松.

为了更好地满足用户的爬取需求,它还提供了免费的Windows、Mac OS X和Linux应用程序,用于构建数据提取器和爬虫、下载数据和与在线帐户同步。此外,用户可以每周、每天或每小时安排抓取任务。

80腿

80legs 是一款功能强大的网络爬虫工具,可根据自定义需求进行配置。它支持获取大量数据,并且可以立即下载提取的数据。80legs提供高性能的网络爬虫,可以快速运行,几秒内获取所需数据

Spinn3r

Spinn3r 允许您从博客、新闻和社交媒体 网站 以及 RSS 和 ATOM 提要中获取所有数据。Spinn3r 与 Firehouse API 一起分发,它管理着 95% 的索引工作。它提供了先进的垃圾邮件保护功能,可以消除垃圾邮件和不恰当的语言使用,从而提高数据安全性。

Spinn3r 索引类似于 Google 的内容并将提取的数据保存在 JSON 文件中。网络爬虫会不断扫描网络并从多个来源寻找更新以获得实时出版物。它的管理控制台允许您控制爬行,而全文搜索允许对原创数据进行复杂查询。

内容抓取器

Content Grabber 是一款面向企业的网络爬虫软件。它允许您创建一个独立的网络爬虫代理。它可以从几乎所有网站 中提取内容,并以您选择的格式将其保存为结构化数据,包括 Excel 报告、XML、CSV 和大多数数据库。

因为它为需要的人提供了许多强大的脚本编辑和调试接口,所以更适合具有高级编程技能的人。允许用户使用 C# 或 VB.NET 调试或编写脚本来控制抓取过程的编程。例如,Content Grabber 可以与 Visual Studio 2013 集成,根据用户的特定需求,对高级、机智的自定义爬虫执行最强大的脚本编辑、调试和单元测试。

氦气刮刀

Helium Scraper 是一款可视化的网络数据爬取软件,当元素之间的相关性较小时效果很好。它是非编码和不可配置的。用户可以根据各种爬取需求访问在线模板。

基本上可以满足用户群的爬取需求。

路径

UiPath 是一款用于免费网络爬虫的机器人流程自动化软件。它可以从大多数第三方应用程序中自动抓取 Web 和桌面数据。如果在 Windows 上运行它,则可以安装自动化流程自动化软件。Uipath 可以跨多个网页以表格格式提取数据。

Uipath 提供了用于进一步爬行的内置工具。这种方法在处理复杂的 UI 时非常有效。截屏工具可以处理单个文本元素、文本组和文本块,例如表格格式的数据提取。

此外,无需编程即可创建智能 Web 代理,但您的内部 .NET 黑客将完全控制数据。

抓取.it

Scrape.it 是一个 node.js 网页抓取软件。这是一个基于云的数据提取工具。它是为具有高级编程技能的人设计的,因为它提供了公共和私有包来发现、重用、更新和与全球数百万开发人员共享代码。其强大的集成将帮助您根据需要构建自定义搜索引擎。

网络哈维

WebHarvy 是一种点击式网页抓取软件。它是为非程序员设计的。WebHarvy 可以自动抓取 网站 中的文本、图像、URL 和电子邮件,并将抓取的内容以各种格式保存。它还提供了内置的调度器和代理支持,可以进行匿名爬网,防止网络爬虫软件被网络服务器拦截。您可以选择通过代理服务器或 VPN 访问目标。

用户可以以多种格式保存从网页中提取的数据。当前版本的 WebHarvy 网络爬虫工具允许您将爬取的数据导出为 XML、CSV、JSON 或 TSV 文件。用户还可以将捕获的数据导出到 SQL 数据库。

内涵

Connotate 是一个自动化的网络爬虫程序,专为企业级 Web 内容提取而设计。它需要企业级解决方案。业务用户无需任何编程即可在几分钟内轻松创建提取代理。用户只需单击一下即可轻松创建提取代理。 查看全部

抓取网页数据php(20+网页采集工具—5分钟提取线上数据网页爬虫)

请查看原文文章:20+网页采集工具-5分钟提取在线数据

网络爬虫(又称数据抽取、数据采集、数据爬虫)现在在很多领域都有广泛的应用。在网络爬虫工具出现之前,它对于没有编程技能的普通人来说是一个神奇的词,它的高进入门槛让人们远离了大数据的大门。而网络爬虫是一种自动数据抓取技术,通过自动爬取数据减少了手动复制粘贴的繁琐步骤,缩短了我们与数据的距离。

使用网络爬虫有什么好处?

它消除了重复复制和粘贴工作的需要。

它将提取的数据转换为结构良好的格式,包括但不限于 Excel、HTML 和 CSV。

它可以帮助您节省时间和金钱,而无需聘请专业数据分析师。

这是营销人员、卖家、记者、YouTube 用户、研究人员和许多其他缺乏技术技能的人的秘诀。

我列出了 20 个最好的网络爬虫工具供您参考。欢迎充分利用它!

八爪鱼

Octoparse 是一个强大的网站 搜索引擎,可以在网站 上提取几乎所有你需要的数据。您可以使用 Octoparse 爬取 网站 的各种功能。它有2种操作模式——任务模板模式和高级模式——非程序员也能快速上手。友好的点击界面可以引导您完成整个提取过程。因此,您可以轻松地将网站的内容提取出来,并在短时间内将其保存为EXCEL、TXT、HTML或数据库等结构化格式。

此外,它还提供计划的云提取,让您实时提取动态数据并在 网站 更新中保持跟踪记录。您还可以通过使用内置的 Regex 和 XPath 配置来准确定位元素,以提取复杂的结构 网站。您不再需要担心 IP 阻塞。Octoparse 提供了一个 IP 代理服务器,它会自动执行 IP,不会被攻击性的 网站 发现。总之,Octoparse 应该能够满足用户最基本或高级的爬虫需求,无需任何编码技能。

Cyotek 网络复制

WebCopy 是对网络爬虫的非常形象的描述。这是一个免费的网站 搜索引擎,允许您将网站 的部分或全部本地复制到您的硬盘以供离线参考。您可以更改其设置以告诉机器人您想如何爬行。此外,您还可以配置域别名、用户代理字符串、默认文档等。

但是,WebCopy 不包括虚拟 DOM 或任何形式的 JavaScript 解析。如果 网站 大量使用 JavaScript 进行操作,WebCopy 可能无法制作真正的副本。由于大量使用 JavaScript,动态 网站 布局可能无法正确处理。

HTTrack

作为网站搜索器的免费软件,HTTrack提供将网站整个下载到您的PC的功能。有适用于Windows、Linux、Sun Solaris等Unix系统的版本,覆盖大部分用户。有趣的是,HTTrack 可以镜像一个站点,也可以将多个站点镜像在一起(使用共享链接)。您可以在“设置”下确定下载网页时同时打开的连接数。您可以从其镜像的 网站 中获取照片、文件和 HTML 代码,并恢复中断的下载。

此外,HTTrack 中提供了代理支持以最大限度地提高速度。

HTTrack 既可以作为命令行程序使用,也可以通过shell 供私有(捕获)或专业(在线网络镜像)使用。适用于具有高级编程能力的用户。

左转

Getleft 是一款免费且易于使用的 网站 爬虫工具。它允许您下载整个 网站 或任何单个网页。启动Getleft后,输入网址,选择要下载的文件,即可开始下载。随着它的进行,它将更改本地浏览的所有链接。此外,它还提供多语言支持。现在,Getleft 支持 14 种语言!然而,它只提供有限的 Ftp 支持,它会下载文件,但不会递归。

总的来说,Getleft 应该能满足用户基本的爬虫需求,不需要更复杂的战术技巧。

刮刀

Scraper 是一个 Chrome 扩展,数据提取能力有限,但对在线研究很有帮助。它还允许将数据导出到 Google 电子表格。该工具适合初学者和专家。您可以使用 OAuth 轻松地将数据复制到剪贴板或将其存储在电子表格中。Scraper 可以自动生成 XPath 来定义要爬取的 URL。它没有提供包罗万象的爬虫服务,但大多数人仍然不需要处理杂乱的配置。

OutWit 中心

OutWit Hub 是 Firefox 的附加组件,具有许多数据提取功能,可简化您的网络搜索。网络爬虫工具可以浏览页面并将提取的信息以适当的格式存储。

OutWit Hub 提供了一个单一的界面,可以根据需要捕获少量或大量的数据。OutWit Hub 允许您从浏览器本身抓取任何网页。它甚至可以创建自动代理来提取数据。

它是最简单的网页抓取工具之一,免费提供,让您无需编写一行代码即可方便地提取网页数据。

分析中心

Parsehub 是一款优秀的网络爬虫,支持使用 AJAX 技术、JavaScript、Cookies 等从 网站 采集数据,其机器学习技术可以读取、分析 Web 文档,然后将其转换为相关数据。

Parsehub 的桌面应用程序支持 Windows、Mac OS X 和 Linux 系统。您甚至可以使用浏览器中内置的 Web 应用程序。

作为免费软件,您最多可以在 Parsehub 中构建五个公共项目。付费订阅计划允许您创建至少 20 个用于爬取 网站 的私人项目。

视觉刮板

VisualScraper 是另一个很棒的免费和非编码网络爬虫程序,具有简单的点击界面。您可以从多个网页获取实时数据,并将提取的数据导出为 CSV、XML、JSON 或 SQL 文件。除了 SaaS,VisualScraper 还提供网络抓取服务,例如数据交付服务和创建软件提取器服务。

Visual Scraper 允许用户安排项目在特定时间运行,或每分钟/天/周/月/年重复该序列。用户可以使用它来频繁地获取新闻、更新、论坛。

抓取中心

Scrapinghub 是一种基于云的数据提取工具,可以帮助成千上万的开发人员获取有价值的数据。其开源的可视化爬取工具让用户无需任何编程知识即可爬取网站。

Scrapinghub 使用 Crawlera,这是一种智能代理微调器,支持绕过机器人对抗措施以轻松抓取大型或受机器人保护的站点。它允许用户通过简单的 HTTP API 从多个 IP 和位置进行爬取,无需代理管理。

Scrapinghub 将整个网页转换为结构化内容。如果其爬虫构建器无法满足您的要求,其专家团队将为您提供帮助。

德喜

作为一款基于浏览器的爬虫,Dexi.io 允许您从任何基于浏览器的网站 中抓取数据,并提供了三种机器人来创建抓取任务——提取器、爬虫和管道。这个免费软件为您的网络抓取提供了一个匿名的网络代理服务器。您提取的数据将在数据存档前在 Dexi.io 的服务器上托管两周,或者您可以将提取的数据直接导出为 JSON 或 CSV 文件。提供付费服务,满足您获取实时数据的需求。

网管网

Webhose.io 使用户能够从来自世界各地的各种干净格式的在线资源中捕获实时数据。使用此网络爬虫,您可以使用覆盖多个来源的多个过滤器来爬取数据并进一步提取多种不同语言的关键字。

您可以将捕获的数据保存为 XML、JSON 和 RSS 格式。并允许用户从其档案中访问历史数据。此外,webhose.io 的爬取数据结果支持多达 80 种语言。用户可以轻松索引和搜索 Webhose.io 抓取的结构化数据。

总体来说,Webhose.io可以满足用户的基本爬取需求。

进口。io

用户可以通过简单地从特定网页导入数据并将数据导出为 CSV 来形成自己的数据集。

无需编写任何代码,您可以在几分钟内轻松抓取数千个网页,并且可以根据需要构建 1,000 多个 API。公共API提供了强大而灵活的功能,可以通过编程控制Import.io,实现数据的自动访问,而Import.io只需点击几下或网站中,即可将网页数据集成到自己的应用中,从而让爬取更轻松.

为了更好地满足用户的爬取需求,它还提供了免费的Windows、Mac OS X和Linux应用程序,用于构建数据提取器和爬虫、下载数据和与在线帐户同步。此外,用户可以每周、每天或每小时安排抓取任务。

80腿

80legs 是一款功能强大的网络爬虫工具,可根据自定义需求进行配置。它支持获取大量数据,并且可以立即下载提取的数据。80legs提供高性能的网络爬虫,可以快速运行,几秒内获取所需数据

Spinn3r

Spinn3r 允许您从博客、新闻和社交媒体 网站 以及 RSS 和 ATOM 提要中获取所有数据。Spinn3r 与 Firehouse API 一起分发,它管理着 95% 的索引工作。它提供了先进的垃圾邮件保护功能,可以消除垃圾邮件和不恰当的语言使用,从而提高数据安全性。

Spinn3r 索引类似于 Google 的内容并将提取的数据保存在 JSON 文件中。网络爬虫会不断扫描网络并从多个来源寻找更新以获得实时出版物。它的管理控制台允许您控制爬行,而全文搜索允许对原创数据进行复杂查询。

内容抓取器

Content Grabber 是一款面向企业的网络爬虫软件。它允许您创建一个独立的网络爬虫代理。它可以从几乎所有网站 中提取内容,并以您选择的格式将其保存为结构化数据,包括 Excel 报告、XML、CSV 和大多数数据库。

因为它为需要的人提供了许多强大的脚本编辑和调试接口,所以更适合具有高级编程技能的人。允许用户使用 C# 或 VB.NET 调试或编写脚本来控制抓取过程的编程。例如,Content Grabber 可以与 Visual Studio 2013 集成,根据用户的特定需求,对高级、机智的自定义爬虫执行最强大的脚本编辑、调试和单元测试。

氦气刮刀

Helium Scraper 是一款可视化的网络数据爬取软件,当元素之间的相关性较小时效果很好。它是非编码和不可配置的。用户可以根据各种爬取需求访问在线模板。

基本上可以满足用户群的爬取需求。

路径

UiPath 是一款用于免费网络爬虫的机器人流程自动化软件。它可以从大多数第三方应用程序中自动抓取 Web 和桌面数据。如果在 Windows 上运行它,则可以安装自动化流程自动化软件。Uipath 可以跨多个网页以表格格式提取数据。

Uipath 提供了用于进一步爬行的内置工具。这种方法在处理复杂的 UI 时非常有效。截屏工具可以处理单个文本元素、文本组和文本块,例如表格格式的数据提取。

此外,无需编程即可创建智能 Web 代理,但您的内部 .NET 黑客将完全控制数据。

抓取.it

Scrape.it 是一个 node.js 网页抓取软件。这是一个基于云的数据提取工具。它是为具有高级编程技能的人设计的,因为它提供了公共和私有包来发现、重用、更新和与全球数百万开发人员共享代码。其强大的集成将帮助您根据需要构建自定义搜索引擎。

网络哈维

WebHarvy 是一种点击式网页抓取软件。它是为非程序员设计的。WebHarvy 可以自动抓取 网站 中的文本、图像、URL 和电子邮件,并将抓取的内容以各种格式保存。它还提供了内置的调度器和代理支持,可以进行匿名爬网,防止网络爬虫软件被网络服务器拦截。您可以选择通过代理服务器或 VPN 访问目标。

用户可以以多种格式保存从网页中提取的数据。当前版本的 WebHarvy 网络爬虫工具允许您将爬取的数据导出为 XML、CSV、JSON 或 TSV 文件。用户还可以将捕获的数据导出到 SQL 数据库。

内涵

Connotate 是一个自动化的网络爬虫程序,专为企业级 Web 内容提取而设计。它需要企业级解决方案。业务用户无需任何编程即可在几分钟内轻松创建提取代理。用户只需单击一下即可轻松创建提取代理。

抓取网页数据php(数据分析机器学习bizcomputer-central-by-ai脚本和浏览器地址栏显示数据)

网站优化 • 优采云 发表了文章 • 0 个评论 • 50 次浏览 • 2021-12-15 05:03

抓取网页数据php浏览器自带的cookie,javascript脚本和浏览器地址栏显示数据

第一次回答,说的不好欢迎打脸。html5,css3,javascript等,这些是最基础的了。视频的话就推荐两个:网易云课堂、欧阳宏伟的博客。图片的话直接去下载高清图片做壁纸吧,有很多。关于js可以在我的博客里面找到。

可以找下我或者各位牛人,

qq群453446009

推荐一个网站:cvflow|computervisionandnaturallanguage,开源的,像素级别的复现视频流之类的,去学学吧。

数据分析机器学习bizcomputer-central-by-ai

我用的是coursera上的中文课程网。

貌似图像是cv2

不是写过网页爬虫么???

看一本c++的《concretevisualprogramming》

爬虫的话,据说国内的博客里有个叫狼哥的人做了一个爬虫,但是是基于谷歌大图搜索开发的。这个多好爬啊,只要懂得用google,各种数据库,各种浏览器兼容,各种格式转换,各种黑名单白名单,各种逻辑查询,代码量少,花销不大,

推荐一个有意思的项目:《菜鸟python教程》

你现在python3应该已经可以了吧。github搜shopify。如果你不嫌麻烦的话还是可以自己试试手写爬虫,爬一下各大网站的。 查看全部

抓取网页数据php(数据分析机器学习bizcomputer-central-by-ai脚本和浏览器地址栏显示数据)

抓取网页数据php浏览器自带的cookie,javascript脚本和浏览器地址栏显示数据

第一次回答,说的不好欢迎打脸。html5,css3,javascript等,这些是最基础的了。视频的话就推荐两个:网易云课堂、欧阳宏伟的博客。图片的话直接去下载高清图片做壁纸吧,有很多。关于js可以在我的博客里面找到。

可以找下我或者各位牛人,

qq群453446009

推荐一个网站:cvflow|computervisionandnaturallanguage,开源的,像素级别的复现视频流之类的,去学学吧。

数据分析机器学习bizcomputer-central-by-ai

我用的是coursera上的中文课程网。

貌似图像是cv2

不是写过网页爬虫么???

看一本c++的《concretevisualprogramming》

爬虫的话,据说国内的博客里有个叫狼哥的人做了一个爬虫,但是是基于谷歌大图搜索开发的。这个多好爬啊,只要懂得用google,各种数据库,各种浏览器兼容,各种格式转换,各种黑名单白名单,各种逻辑查询,代码量少,花销不大,

推荐一个有意思的项目:《菜鸟python教程》

你现在python3应该已经可以了吧。github搜shopify。如果你不嫌麻烦的话还是可以自己试试手写爬虫,爬一下各大网站的。

抓取网页数据php( junjie这篇文章主要介绍了,_CUSTOMREQUEST参数的运用(图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 64 次浏览 • 2021-12-14 21:03

junjie这篇文章主要介绍了,_CUSTOMREQUEST参数的运用(图))

PHP curl 实现302跳转后抓取页面的例子

更新时间:2014-07-04 10:43:25 投稿:俊杰

本文文章主要介绍PHP curl实现302跳转后的页面的例子,主要是CURLOPT_CUSTOMREQUEST参数的使用,需要的朋友可以参考

PHP的CURL正常抓取页面程序如下:

$url = 'http://www.baidu.com';

$ch = curl_init();

curl_setopt($ch, CURLOPT_URL, $url);

curl_setopt($ch, CURLOPT_VERBOSE, true);

curl_setopt($ch, CURLOPT_HEADER, true);

curl_setopt($ch, CURLOPT_NOBODY, true);

curl_setopt($ch, CURLOPT_CUSTOMREQUEST, 'GET');

curl_setopt($ch, CURLOPT_RETURNTRANSFER, true);

curl_setopt($ch, CURLOPT_TIMEOUT, 20);

curl_setopt($ch, CURLOPT_AUTOREFERER, true);

curl_setopt($ch, CURLOPT_FOLLOWLOCATION, true);

$ret = curl_exec($ch);

$info = curl_getinfo($ch);

curl_close($ch);

如果抓取到302状态,那是因为在爬取过程中,有些跳转需要给下一个链接传递参数,如果没有收到相应的参数,下一个链接也被设置了,就是非法访问。

curl_setopt($curl, CURLOPT_CUSTOMREQUEST, 'GET');

显示应该是正常的。

上面是用来抓取函数的,应该几乎没有问题。您可以查看 CURLOPT_CUSTOMREQUEST 相关信息。

使用自定义请求消息而不是“GET”或“HEAD”作为 HTTP 请求。这是用于执行“DELETE”或其他更模糊的 HTTP 请求。有效值为“GET”、“POST”、“CONNECT”等。换句话说,不要在此处输入整个 HTTP 请求。例如,输入“GET /index.html HTTP/1.0\r\n\r\n”是错误的。 查看全部

抓取网页数据php(

junjie这篇文章主要介绍了,_CUSTOMREQUEST参数的运用(图))

PHP curl 实现302跳转后抓取页面的例子

更新时间:2014-07-04 10:43:25 投稿:俊杰

本文文章主要介绍PHP curl实现302跳转后的页面的例子,主要是CURLOPT_CUSTOMREQUEST参数的使用,需要的朋友可以参考

PHP的CURL正常抓取页面程序如下:

$url = 'http://www.baidu.com';

$ch = curl_init();

curl_setopt($ch, CURLOPT_URL, $url);

curl_setopt($ch, CURLOPT_VERBOSE, true);

curl_setopt($ch, CURLOPT_HEADER, true);

curl_setopt($ch, CURLOPT_NOBODY, true);

curl_setopt($ch, CURLOPT_CUSTOMREQUEST, 'GET');

curl_setopt($ch, CURLOPT_RETURNTRANSFER, true);

curl_setopt($ch, CURLOPT_TIMEOUT, 20);

curl_setopt($ch, CURLOPT_AUTOREFERER, true);

curl_setopt($ch, CURLOPT_FOLLOWLOCATION, true);

$ret = curl_exec($ch);

$info = curl_getinfo($ch);

curl_close($ch);

如果抓取到302状态,那是因为在爬取过程中,有些跳转需要给下一个链接传递参数,如果没有收到相应的参数,下一个链接也被设置了,就是非法访问。

curl_setopt($curl, CURLOPT_CUSTOMREQUEST, 'GET');

显示应该是正常的。

上面是用来抓取函数的,应该几乎没有问题。您可以查看 CURLOPT_CUSTOMREQUEST 相关信息。

使用自定义请求消息而不是“GET”或“HEAD”作为 HTTP 请求。这是用于执行“DELETE”或其他更模糊的 HTTP 请求。有效值为“GET”、“POST”、“CONNECT”等。换句话说,不要在此处输入整个 HTTP 请求。例如,输入“GET /index.html HTTP/1.0\r\n\r\n”是错误的。

抓取网页数据php(本文就用Java给大家演示怎样抓取站点的数据:(1))

网站优化 • 优采云 发表了文章 • 0 个评论 • 46 次浏览 • 2021-12-14 00:19

原文链接:

有时因为各种原因。我们需要从某个站点采集数据。但是因为不同的站点显示的数据略有不同!

本文使用Java向大家展示如何抓取网站的数据:(1)抓取原创网页数据。(2)抓取网页Javascript返回的数据。

一、 抓取原创网页。

在这个例子中,我们将从上面获取 ip 查询的结果:

第一步:打开这个网页。然后输入IP:111.142.55.73,点击查询按钮。您将能够看到网页上显示的结果:

第二步:查看网页源代码,我们在源代码中看到这一段:

从这里可以看到。再次请求网页后显示查询结果。

查询后看网页地址:

换句话说,我们只需要访问一个看起来像这样的 URL。可以得到ip查询的结果,然后看代码:

public void captureHtml(String ip) throws Exception {

String strURL = "http://ip.chinaz.com/?

<p>IP=" + ip;

URL url = new URL(strURL);

HttpURLConnection httpConn = (HttpURLConnection) url.openConnection();

InputStreamReader input = new InputStreamReader(httpConn

.getInputStream(), "utf-8");

BufferedReader bufReader = new BufferedReader(input);

String line = "";

StringBuilder contentBuf = new StringBuilder();