抓取网页数据php

抓取网页数据phphtml5的php可以通过sqlite数据库来访问

网站优化 • 优采云 发表了文章 • 0 个评论 • 97 次浏览 • 2022-09-03 09:06

抓取网页数据phphtml5的php脚本可以通过sqlite数据库来进行网页数据的访问,当然,这可以进行多个页面数据的同步,并且执行效率很高。除了数据库读写的问题外,这个特性还有一个用途,就是在网页上进行页面视频的读写,并且都保存为文件,比如可以通过php脚本的:来访问并执行相应的操作。

抓取数据抓取任何用户访问过的网页,比如qq浏览器点击一个淘宝的链接,这样,就抓取了qq浏览器的页面地址中的qq这个url,而这个url用于进行php对应的脚本的读写操作。获取cookiecookie机制的存在为php的多页面的缓存加上了一个很重要的步骤,就是获取当前页的cookie地址,这个地址就是浏览器地址的绝对路径,而且在数据库中使用了对应的字段进行存储,如下:然后在下一次数据库查询的时候,从数据库中获取相应的字段,进行查询,从而获取下一页的数据,浏览器的抓取策略是从一个url中读取文件的第一页数据,对应的cookie就存放在一个string类型的url中的response结构体中。

获取单页面爬虫数据有两种获取方式,一种是获取单页面的数据,并且这个数据在整个网页中是唯一的,比如从一个地址找到它的返回页面,这个地址就是返回页面的url,那么需要从这个url中获取相应的数据的时候,就可以使用request.get或者request.post来完成相应的操作。另外一种方式是获取网页的单页面数据,也就是不同的url有不同的返回页面,这种方式是通过返回的数据来识别页面的位置的,也就是经常讲的多跳转。

比如给某人发消息,如果发送到某个微信页面了,那么微信会一直保存这个页面在数据库中。因此,可以通过设置某个字段来指定将第几个url发送到微信并使用在微信对应的地址来请求这个字段。ajax获取ajax实际上是javascript把请求加入到http请求栈的问题,是php的一个特性,javascript在加载完网页之后,在数据库中进行查询操作之前,把一些数据提交给服务器,并要把数据字典转换成为表格字段,然后再传给后面的数据库执行更新。

通过ajax方式,前端可以是发送post请求,服务器端可以是发送get请求。根据ajax方式不同,其执行时间也不同,有兴趣的同学可以关注下。实现拦截拦截的实现过程通常有两种方式,一种是使用循环(pipe),一种是使用生成器(generator)。pipe的使用在javascript中,会发送post请求的请求串,接受请求后,定义response中包含response.readheader为一个固定值的数组。然后,遍历这个数组,遍历到对应的一个就增加一。 查看全部

抓取网页数据phphtml5的php可以通过sqlite数据库来访问

抓取网页数据phphtml5的php脚本可以通过sqlite数据库来进行网页数据的访问,当然,这可以进行多个页面数据的同步,并且执行效率很高。除了数据库读写的问题外,这个特性还有一个用途,就是在网页上进行页面视频的读写,并且都保存为文件,比如可以通过php脚本的:来访问并执行相应的操作。

抓取数据抓取任何用户访问过的网页,比如qq浏览器点击一个淘宝的链接,这样,就抓取了qq浏览器的页面地址中的qq这个url,而这个url用于进行php对应的脚本的读写操作。获取cookiecookie机制的存在为php的多页面的缓存加上了一个很重要的步骤,就是获取当前页的cookie地址,这个地址就是浏览器地址的绝对路径,而且在数据库中使用了对应的字段进行存储,如下:然后在下一次数据库查询的时候,从数据库中获取相应的字段,进行查询,从而获取下一页的数据,浏览器的抓取策略是从一个url中读取文件的第一页数据,对应的cookie就存放在一个string类型的url中的response结构体中。

获取单页面爬虫数据有两种获取方式,一种是获取单页面的数据,并且这个数据在整个网页中是唯一的,比如从一个地址找到它的返回页面,这个地址就是返回页面的url,那么需要从这个url中获取相应的数据的时候,就可以使用request.get或者request.post来完成相应的操作。另外一种方式是获取网页的单页面数据,也就是不同的url有不同的返回页面,这种方式是通过返回的数据来识别页面的位置的,也就是经常讲的多跳转。

比如给某人发消息,如果发送到某个微信页面了,那么微信会一直保存这个页面在数据库中。因此,可以通过设置某个字段来指定将第几个url发送到微信并使用在微信对应的地址来请求这个字段。ajax获取ajax实际上是javascript把请求加入到http请求栈的问题,是php的一个特性,javascript在加载完网页之后,在数据库中进行查询操作之前,把一些数据提交给服务器,并要把数据字典转换成为表格字段,然后再传给后面的数据库执行更新。

通过ajax方式,前端可以是发送post请求,服务器端可以是发送get请求。根据ajax方式不同,其执行时间也不同,有兴趣的同学可以关注下。实现拦截拦截的实现过程通常有两种方式,一种是使用循环(pipe),一种是使用生成器(generator)。pipe的使用在javascript中,会发送post请求的请求串,接受请求后,定义response中包含response.readheader为一个固定值的数组。然后,遍历这个数组,遍历到对应的一个就增加一。

php可以直接读php文件调用phpapi读取数据,比如get、post

网站优化 • 优采云 发表了文章 • 0 个评论 • 91 次浏览 • 2022-08-28 03:09

抓取网页数据php可以直接读php文件edit调用phpapi读取数据,比如get、post如果不需要做数据库连接,那么可以用access_log直接查询sql语句。如果数据量比较大,需要同时读多个文件,还是存到本地吧,目前csdn几乎全部都是本地存储,你需要用到其他的技术把多个文件合并成一个excel如果你主要用于登录验证等功能的开发,那可以用:openidauthentication校验更多php资源,请参考我们的:php极客基地()/。

阿里云ecs套餐,ceph集群,自己买硬件,就可以实现单台电脑的集群,

我不是php的内行,所以这个问题,我也帮不了你,但我想知道,网站服务器的硬件如何做到。一般就是服务器内置硬件的处理能力,1万个,10000-15000元一台。具体硬件处理能力请联系专业人士。

不知道你们还需要多少流量,像阿里云都是1t一年,比如阿里云集群服务器套餐,单台服务器5000元一年,可以去看看,以及php下面的架构有很多,找一个靠谱的,安全稳定的php架构,5~6kw也不是问题,

找家靠谱的厂商处理下重复数据呗

你需要的应该是不一样的处理方式。也是可以做到的。

谢邀,1万台服务器么,估计你需要用开源的es32了吧, 查看全部

php可以直接读php文件调用phpapi读取数据,比如get、post

抓取网页数据php可以直接读php文件edit调用phpapi读取数据,比如get、post如果不需要做数据库连接,那么可以用access_log直接查询sql语句。如果数据量比较大,需要同时读多个文件,还是存到本地吧,目前csdn几乎全部都是本地存储,你需要用到其他的技术把多个文件合并成一个excel如果你主要用于登录验证等功能的开发,那可以用:openidauthentication校验更多php资源,请参考我们的:php极客基地()/。

阿里云ecs套餐,ceph集群,自己买硬件,就可以实现单台电脑的集群,

我不是php的内行,所以这个问题,我也帮不了你,但我想知道,网站服务器的硬件如何做到。一般就是服务器内置硬件的处理能力,1万个,10000-15000元一台。具体硬件处理能力请联系专业人士。

不知道你们还需要多少流量,像阿里云都是1t一年,比如阿里云集群服务器套餐,单台服务器5000元一年,可以去看看,以及php下面的架构有很多,找一个靠谱的,安全稳定的php架构,5~6kw也不是问题,

找家靠谱的厂商处理下重复数据呗

你需要的应该是不一样的处理方式。也是可以做到的。

谢邀,1万台服务器么,估计你需要用开源的es32了吧,

抓取网页数据phpi+还有mysql阿里云有几个日志服务器

网站优化 • 优采云 发表了文章 • 0 个评论 • 82 次浏览 • 2022-08-25 02:03

抓取网页数据phpi++还有mysql阿里云有几个日志服务器,你试试看。这些其实都不是问题的关键是这些应用程序你都是在同一个电脑上完成,和mathematica一样用的是网页浏览器。那些开发环境、编译环境什么的都是小意思了。这些都是开源的,你要学习可以自己找下。我很赞成,要学java,因为php太简单了,而java是世界上最好的语言,没有之一。欢迎交流。

[git]教你怎么从服务器上拉取到你需要的数据。

php自己封装一套框架,本地用sed,

用mysql本地用java自己封装一套系统

把简单的爬虫写起来其实对会php的人就差不多了,这些框架都不用手写,简单的写写爬虫就好了,写io读写就行了,php本身不用像c那样封装任何东西,而是把请求和返回结果抽象成python2中的数据结构(类似于db.dd)。这样你就可以直接用java自己封装的数据结构去完成对接php数据库的需求。

你这样先不考虑是否要学习爬虫,假设你要学php爬虫。买本薄一点的书,把里面基础语法搞清楚,就算你要写demo也就几天的事。剩下就是真正要爬取数据并应用的时候,分库分表、分层、分页等,还有异步请求等。看你想爬哪些网站。以上对php是不是初学者来说都是先不考虑的问题,考虑这些最基础的理论。等你真正开始做,用到的时候就不是难事了。

抓取数据之前你要学会甄别数据、设置目标数据,如果数据是真实的,那么你只要请求和读取就行了,如果数据是pdf什么的可能就需要一点结构化处理和文本处理方面的知识。这些抓取的东西你自己写完可能需要几个星期,可能一天就写完了。另外,你可以有想到可能以后还要用到的的其他的解决方案,先学着把需求优化,看完是否真的适合你,这个决定你后面需要加班加点去实现的东西。如果你也是个初学者,我建议你先解决吃饭问题再考虑下面的问题。 查看全部

抓取网页数据phpi+还有mysql阿里云有几个日志服务器

抓取网页数据phpi++还有mysql阿里云有几个日志服务器,你试试看。这些其实都不是问题的关键是这些应用程序你都是在同一个电脑上完成,和mathematica一样用的是网页浏览器。那些开发环境、编译环境什么的都是小意思了。这些都是开源的,你要学习可以自己找下。我很赞成,要学java,因为php太简单了,而java是世界上最好的语言,没有之一。欢迎交流。

[git]教你怎么从服务器上拉取到你需要的数据。

php自己封装一套框架,本地用sed,

用mysql本地用java自己封装一套系统

把简单的爬虫写起来其实对会php的人就差不多了,这些框架都不用手写,简单的写写爬虫就好了,写io读写就行了,php本身不用像c那样封装任何东西,而是把请求和返回结果抽象成python2中的数据结构(类似于db.dd)。这样你就可以直接用java自己封装的数据结构去完成对接php数据库的需求。

你这样先不考虑是否要学习爬虫,假设你要学php爬虫。买本薄一点的书,把里面基础语法搞清楚,就算你要写demo也就几天的事。剩下就是真正要爬取数据并应用的时候,分库分表、分层、分页等,还有异步请求等。看你想爬哪些网站。以上对php是不是初学者来说都是先不考虑的问题,考虑这些最基础的理论。等你真正开始做,用到的时候就不是难事了。

抓取数据之前你要学会甄别数据、设置目标数据,如果数据是真实的,那么你只要请求和读取就行了,如果数据是pdf什么的可能就需要一点结构化处理和文本处理方面的知识。这些抓取的东西你自己写完可能需要几个星期,可能一天就写完了。另外,你可以有想到可能以后还要用到的的其他的解决方案,先学着把需求优化,看完是否真的适合你,这个决定你后面需要加班加点去实现的东西。如果你也是个初学者,我建议你先解决吃饭问题再考虑下面的问题。

php提供网页提取接口函数websqlphp-sql提供了一个映射关系和传递数据功能

网站优化 • 优采云 发表了文章 • 0 个评论 • 128 次浏览 • 2022-07-02 17:03

抓取网页数据php的开发语言是php提供网页提取接口函数websqlphp-sql提供了一个映射关系和传递数据功能编写代码爬虫爬虫具体的代码这里不详细阐述使用php编写爬虫的工具是laravellaravel是由ryanknapp在2005年编写的,是为web开发打造的一个构建网站的框架。laravel已经成为目前建设、发展和壮大应用最流行的网站开发框架。

laravel最初是作为一个web界面语言设计的,可以使用其构建http、https网站。php语言是根据c计划开发的。php中是不允许动态的,php来构建http和https接口,其中还有许多php代码上的限制,对于php环境本身的支持,一些基本的变量在运行时必须使用php定义,例如整数、字符串、数组、布尔、方法和函数等。

此外,php没有timeline来控制它执行的速度。php传统的文件扩展名是“.php”,和lnmp不同。建议使用“php.2.4以上的版本”。php.2.4以上的版本就在common标签上附加了php_mixed_lib的可执行文件标签,这个文件可以在不同的目录下存在。作为php3.0版本的补充,php_mixed_lib就增加了三个方法。

php_public:静态方法,有它不能直接传递函数参数给定的方法,只能接受参数后传递给调用方的方法php_public:php扩展方法,有它就可以传递函数的参数给某个方法,后面就可以传递给定个方法php_extra:php扩展库的方法,只能传递参数给一个方法php_extra:php扩展库的方法,有它传递参数给某个方法,后面就可以传递给某个方法编写php爬虫时,一定要将页面数据采集下来laravel默认的服务器是vhostfile,如果要加上http代理可以直接使用这个脚本:define_cache_reference("/http",localhost:330。

6);

1、工作流图图中的url作为一个点,是服务器需要访问的请求url,我们可以用prefix这个方法获取页面的唯一标识值和版本,这样对应apache和nginx,获取header也是唯一标识值和版本。

2、组件laravel还有许多组件,包括验证流程单、服务器启动和停止、信息传递、页面载入和返回,这些是交给代理来执行的,因此不用prefix来标识它们,这样也更容易读取。prefix是apache和nginx的标识符,一般这样的作用是域名或ip在本地偏移的二进制序列。

3、关联参数prefix的参数将参数分组为一个个等号(_)的方式:如{"content-type":"text/plain"}这个符号表示你希望使用哪种文本类型,就加上对应的content-type对应的参数,不然所有等号(_)的方式全给你。

4、按照apache和nginx的要求去 查看全部

php提供网页提取接口函数websqlphp-sql提供了一个映射关系和传递数据功能

抓取网页数据php的开发语言是php提供网页提取接口函数websqlphp-sql提供了一个映射关系和传递数据功能编写代码爬虫爬虫具体的代码这里不详细阐述使用php编写爬虫的工具是laravellaravel是由ryanknapp在2005年编写的,是为web开发打造的一个构建网站的框架。laravel已经成为目前建设、发展和壮大应用最流行的网站开发框架。

laravel最初是作为一个web界面语言设计的,可以使用其构建http、https网站。php语言是根据c计划开发的。php中是不允许动态的,php来构建http和https接口,其中还有许多php代码上的限制,对于php环境本身的支持,一些基本的变量在运行时必须使用php定义,例如整数、字符串、数组、布尔、方法和函数等。

此外,php没有timeline来控制它执行的速度。php传统的文件扩展名是“.php”,和lnmp不同。建议使用“php.2.4以上的版本”。php.2.4以上的版本就在common标签上附加了php_mixed_lib的可执行文件标签,这个文件可以在不同的目录下存在。作为php3.0版本的补充,php_mixed_lib就增加了三个方法。

php_public:静态方法,有它不能直接传递函数参数给定的方法,只能接受参数后传递给调用方的方法php_public:php扩展方法,有它就可以传递函数的参数给某个方法,后面就可以传递给定个方法php_extra:php扩展库的方法,只能传递参数给一个方法php_extra:php扩展库的方法,有它传递参数给某个方法,后面就可以传递给某个方法编写php爬虫时,一定要将页面数据采集下来laravel默认的服务器是vhostfile,如果要加上http代理可以直接使用这个脚本:define_cache_reference("/http",localhost:330。

6);

1、工作流图图中的url作为一个点,是服务器需要访问的请求url,我们可以用prefix这个方法获取页面的唯一标识值和版本,这样对应apache和nginx,获取header也是唯一标识值和版本。

2、组件laravel还有许多组件,包括验证流程单、服务器启动和停止、信息传递、页面载入和返回,这些是交给代理来执行的,因此不用prefix来标识它们,这样也更容易读取。prefix是apache和nginx的标识符,一般这样的作用是域名或ip在本地偏移的二进制序列。

3、关联参数prefix的参数将参数分组为一个个等号(_)的方式:如{"content-type":"text/plain"}这个符号表示你希望使用哪种文本类型,就加上对应的content-type对应的参数,不然所有等号(_)的方式全给你。

4、按照apache和nginx的要求去

[精选] 模拟登陆并抓取数据,用php也是可以做到的

网站优化 • 优采云 发表了文章 • 0 个评论 • 50 次浏览 • 2022-06-21 03:31

点击加入:

商务合作请加微信(QQ):2230304070

精选文章正文

服务器活动推荐:【腾讯云12月份服务器限时秒杀活动,最低99元】活动地址:

使用PHP的Curl扩展库可以模拟实现登录,并抓取一些需要用户账号登录以后才能查看的数据。具体实现的流程如下

1. 首先需要对相应的登录页面的html源代码进行分析,获得一些必要的信息:

1)登录页面的地址;

2)验证码的地址;

3)登录表单需要提交的各个字段的名称和提交方式;

4)登录表单提交的地址;

5)另外要需要知道要抓取的数据所在的地址。

2. 获取cookie并存储(针对使用cookie文件的网站)

$login_url = 'http://www.xxxxx'; //登录页面地址<br />$cookie_file = dirname(__FILE__)."/pic.cookie"; //cookie文件存放位置(自定义)<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $login_url);<br />curl_setopt($ch, CURLOPT_HEADER, 0);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER,1);<br />curl_setopt($ch, CURLOPT_COOKIEJAR, $cookie_file);<br />curl_exec($ch);<br />curl_close($ch);<br />

3. 获取验证码并存储(针对使用验证码的网站)

$verify_url = "http://www.xxxx"; //验证码地址<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $verify_url);<br />curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie_file);<br />curl_setopt($ch, CURLOPT_HEADER, 0);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER, 1);<br />$verify_img = curl_exec($ch);<br />curl_close($ch);<br />$fp = fopen("./verify/verifyCode.png",'w'); //把抓取到的图片文件写入本地图片文件保存<br />fwrite($fp, $verify_img);<br />fclose($fp);<br />

说明:

由于不能实现验证码的识别,所以我这里的做法是,把验证码图片抓取下来存放到本地文件中,然后在自己项目中的html页面中显示,让用户去填写,等用户填写完账号、密码和验证码,并点击提交按钮之后再去进行下一步的操作。

4. 模拟提交登录表单:

$ post_url = 'http://www.xxxx'; //登录表单提交地址<br />$post = "username=$account&password=$password&seccodeverify=$verifyCode";//表单提交的数据(根据表单字段名和用户输入决定)<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $ post_url);<br />curl_setopt($ch, CURLOPT_HEADER, false);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER,1);<br />curl_setopt($ch, CURLOPT_POSTFIELDS, $post); //提交方式为post<br />curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie_file);<br />curl_exec($ch);<br />curl_close($ch);<br />

5. 抓取数据:

$data_url = "http://www.xxxx"; //数据所在地址<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $data_url);<br />curl_setopt($ch, CURLOPT_HEADER, false);<br />curl_setopt($ch, CURLOPT_HEADER, 0);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER,0);<br />curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie_file);<br />$data = curl_exec($ch);<br />curl_close($ch);<br />

到目前为止,已经把数据所在地址的这个页面都抓取下来存储在字符串变量$data中了。

需要注意的是抓取下来的是一个网页的html源代码,也就是说这个字符串中不仅包含了你想要的数据,还包含了许多的html标签等你不想要的东西。所以如果你想要从中提取出你需要的数据的话,你还要对存放数据的页面的html代码进行分析,然后结合字符串操作函数、正则匹配等方法从中提取出你想要的数据。 查看全部

[精选] 模拟登陆并抓取数据,用php也是可以做到的

点击加入:

商务合作请加微信(QQ):2230304070

精选文章正文

服务器活动推荐:【腾讯云12月份服务器限时秒杀活动,最低99元】活动地址:

使用PHP的Curl扩展库可以模拟实现登录,并抓取一些需要用户账号登录以后才能查看的数据。具体实现的流程如下

1. 首先需要对相应的登录页面的html源代码进行分析,获得一些必要的信息:

1)登录页面的地址;

2)验证码的地址;

3)登录表单需要提交的各个字段的名称和提交方式;

4)登录表单提交的地址;

5)另外要需要知道要抓取的数据所在的地址。

2. 获取cookie并存储(针对使用cookie文件的网站)

$login_url = 'http://www.xxxxx'; //登录页面地址<br />$cookie_file = dirname(__FILE__)."/pic.cookie"; //cookie文件存放位置(自定义)<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $login_url);<br />curl_setopt($ch, CURLOPT_HEADER, 0);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER,1);<br />curl_setopt($ch, CURLOPT_COOKIEJAR, $cookie_file);<br />curl_exec($ch);<br />curl_close($ch);<br />

3. 获取验证码并存储(针对使用验证码的网站)

$verify_url = "http://www.xxxx"; //验证码地址<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $verify_url);<br />curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie_file);<br />curl_setopt($ch, CURLOPT_HEADER, 0);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER, 1);<br />$verify_img = curl_exec($ch);<br />curl_close($ch);<br />$fp = fopen("./verify/verifyCode.png",'w'); //把抓取到的图片文件写入本地图片文件保存<br />fwrite($fp, $verify_img);<br />fclose($fp);<br />

说明:

由于不能实现验证码的识别,所以我这里的做法是,把验证码图片抓取下来存放到本地文件中,然后在自己项目中的html页面中显示,让用户去填写,等用户填写完账号、密码和验证码,并点击提交按钮之后再去进行下一步的操作。

4. 模拟提交登录表单:

$ post_url = 'http://www.xxxx'; //登录表单提交地址<br />$post = "username=$account&password=$password&seccodeverify=$verifyCode";//表单提交的数据(根据表单字段名和用户输入决定)<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $ post_url);<br />curl_setopt($ch, CURLOPT_HEADER, false);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER,1);<br />curl_setopt($ch, CURLOPT_POSTFIELDS, $post); //提交方式为post<br />curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie_file);<br />curl_exec($ch);<br />curl_close($ch);<br />

5. 抓取数据:

$data_url = "http://www.xxxx"; //数据所在地址<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $data_url);<br />curl_setopt($ch, CURLOPT_HEADER, false);<br />curl_setopt($ch, CURLOPT_HEADER, 0);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER,0);<br />curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie_file);<br />$data = curl_exec($ch);<br />curl_close($ch);<br />

到目前为止,已经把数据所在地址的这个页面都抓取下来存储在字符串变量$data中了。

需要注意的是抓取下来的是一个网页的html源代码,也就是说这个字符串中不仅包含了你想要的数据,还包含了许多的html标签等你不想要的东西。所以如果你想要从中提取出你需要的数据的话,你还要对存放数据的页面的html代码进行分析,然后结合字符串操作函数、正则匹配等方法从中提取出你想要的数据。

web语言基础(vuejs/angularjs)学习经验和教训之谈

网站优化 • 优采云 发表了文章 • 0 个评论 • 106 次浏览 • 2022-06-09 04:04

抓取网页数据php、jsp、asp看到简历数据前端、java看到项目的地址的页面/地址多、复杂、慢

2、读取返回值变量及其使用alibaba。com:返回值,包括两个部分,一个包括alibaba。com的页面信息,一个是职位详情页的内容alibaba。com:status是项目区域和职位详情页的链接,可获取项目区域的数据alibaba。com:item是对应职位详情页的条件查询匹配条件java输入项目的名称“java开发工程师”,返回java开发工程师的简历数据alibaba。

com:返回词库里的数据,获取java开发工程师的职位详情页内容alibaba。com:定义模拟表,返回实际职位的“描述”alibaba。com:返回所有职位的职位信息、公司名、工作地点、薪资。

并不请自来~!先介绍一下我自己情况:第一年从新手到前端老司机,主要是coffeescript+php语言。历经第一年的工作中遇到的坑,也总结了一下学习经验和教训,同时算做自己这一年的回忆。刚好最近公司招聘管理岗,赶上为公司招聘管理岗。想到知乎一直有大神分享博客园博主《做完一个项目就想跳槽》这篇文章,基本过程如下:后端同学:了解coffeescript+php框架前端同学:web语言基础(vuejs/angularjs)前端分析最近经验之谈刚开始接触springcloud,学习dubbo等等一些在之前并没有过接触,需要一定基础:我自己先花了10天完成了一个项目,如下图:这个项目包括入职前,入职中,入职后的日常工作和部分学习的开源代码,自己想学习代码,再开始填坑。并且:。

1、列出了自己这一年踩的坑,共31个。

2、整理出有效的解决方案。

3、学习规划,找时间不管任何东西,一定要养成一个学习习惯,可以和朋友讨论,

4、对比学习框架,花了10天时间找到了合适的框架,自己也逐渐成长,将结果记录下来。

5、最后, 查看全部

web语言基础(vuejs/angularjs)学习经验和教训之谈

抓取网页数据php、jsp、asp看到简历数据前端、java看到项目的地址的页面/地址多、复杂、慢

2、读取返回值变量及其使用alibaba。com:返回值,包括两个部分,一个包括alibaba。com的页面信息,一个是职位详情页的内容alibaba。com:status是项目区域和职位详情页的链接,可获取项目区域的数据alibaba。com:item是对应职位详情页的条件查询匹配条件java输入项目的名称“java开发工程师”,返回java开发工程师的简历数据alibaba。

com:返回词库里的数据,获取java开发工程师的职位详情页内容alibaba。com:定义模拟表,返回实际职位的“描述”alibaba。com:返回所有职位的职位信息、公司名、工作地点、薪资。

并不请自来~!先介绍一下我自己情况:第一年从新手到前端老司机,主要是coffeescript+php语言。历经第一年的工作中遇到的坑,也总结了一下学习经验和教训,同时算做自己这一年的回忆。刚好最近公司招聘管理岗,赶上为公司招聘管理岗。想到知乎一直有大神分享博客园博主《做完一个项目就想跳槽》这篇文章,基本过程如下:后端同学:了解coffeescript+php框架前端同学:web语言基础(vuejs/angularjs)前端分析最近经验之谈刚开始接触springcloud,学习dubbo等等一些在之前并没有过接触,需要一定基础:我自己先花了10天完成了一个项目,如下图:这个项目包括入职前,入职中,入职后的日常工作和部分学习的开源代码,自己想学习代码,再开始填坑。并且:。

1、列出了自己这一年踩的坑,共31个。

2、整理出有效的解决方案。

3、学习规划,找时间不管任何东西,一定要养成一个学习习惯,可以和朋友讨论,

4、对比学习框架,花了10天时间找到了合适的框架,自己也逐渐成长,将结果记录下来。

5、最后,

[精选] 模拟登陆并抓取数据,用php也是可以做到的

网站优化 • 优采云 发表了文章 • 0 个评论 • 85 次浏览 • 2022-06-07 21:42

点击加入:

商务合作请加微信(QQ):2230304070

精选文章正文

服务器活动推荐:【腾讯云12月份服务器限时秒杀活动,最低99元】活动地址:

使用PHP的Curl扩展库可以模拟实现登录,并抓取一些需要用户账号登录以后才能查看的数据。具体实现的流程如下

1. 首先需要对相应的登录页面的html源代码进行分析,获得一些必要的信息:

1)登录页面的地址;

2)验证码的地址;

3)登录表单需要提交的各个字段的名称和提交方式;

4)登录表单提交的地址;

5)另外要需要知道要抓取的数据所在的地址。

2. 获取cookie并存储(针对使用cookie文件的网站)

$login_url = 'http://www.xxxxx'; //登录页面地址<br />$cookie_file = dirname(__FILE__)."/pic.cookie"; //cookie文件存放位置(自定义)<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $login_url);<br />curl_setopt($ch, CURLOPT_HEADER, 0);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER,1);<br />curl_setopt($ch, CURLOPT_COOKIEJAR, $cookie_file);<br />curl_exec($ch);<br />curl_close($ch);<br />

3. 获取验证码并存储(针对使用验证码的网站)

$verify_url = "http://www.xxxx"; //验证码地址<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $verify_url);<br />curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie_file);<br />curl_setopt($ch, CURLOPT_HEADER, 0);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER, 1);<br />$verify_img = curl_exec($ch);<br />curl_close($ch);<br />$fp = fopen("./verify/verifyCode.png",'w'); //把抓取到的图片文件写入本地图片文件保存<br />fwrite($fp, $verify_img);<br />fclose($fp);<br />

说明:

由于不能实现验证码的识别,所以我这里的做法是,把验证码图片抓取下来存放到本地文件中,然后在自己项目中的html页面中显示,让用户去填写,等用户填写完账号、密码和验证码,并点击提交按钮之后再去进行下一步的操作。

4. 模拟提交登录表单:

$ post_url = 'http://www.xxxx'; //登录表单提交地址<br />$post = "username=$account&password=$password&seccodeverify=$verifyCode";//表单提交的数据(根据表单字段名和用户输入决定)<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $ post_url);<br />curl_setopt($ch, CURLOPT_HEADER, false);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER,1);<br />curl_setopt($ch, CURLOPT_POSTFIELDS, $post); //提交方式为post<br />curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie_file);<br />curl_exec($ch);<br />curl_close($ch);<br />

5. 抓取数据:

$data_url = "http://www.xxxx"; //数据所在地址<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $data_url);<br />curl_setopt($ch, CURLOPT_HEADER, false);<br />curl_setopt($ch, CURLOPT_HEADER, 0);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER,0);<br />curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie_file);<br />$data = curl_exec($ch);<br />curl_close($ch);<br />

到目前为止,已经把数据所在地址的这个页面都抓取下来存储在字符串变量$data中了。

需要注意的是抓取下来的是一个网页的html源代码,也就是说这个字符串中不仅包含了你想要的数据,还包含了许多的html标签等你不想要的东西。所以如果你想要从中提取出你需要的数据的话,你还要对存放数据的页面的html代码进行分析,然后结合字符串操作函数、正则匹配等方法从中提取出你想要的数据。 查看全部

[精选] 模拟登陆并抓取数据,用php也是可以做到的

点击加入:

商务合作请加微信(QQ):2230304070

精选文章正文

服务器活动推荐:【腾讯云12月份服务器限时秒杀活动,最低99元】活动地址:

使用PHP的Curl扩展库可以模拟实现登录,并抓取一些需要用户账号登录以后才能查看的数据。具体实现的流程如下

1. 首先需要对相应的登录页面的html源代码进行分析,获得一些必要的信息:

1)登录页面的地址;

2)验证码的地址;

3)登录表单需要提交的各个字段的名称和提交方式;

4)登录表单提交的地址;

5)另外要需要知道要抓取的数据所在的地址。

2. 获取cookie并存储(针对使用cookie文件的网站)

$login_url = 'http://www.xxxxx'; //登录页面地址<br />$cookie_file = dirname(__FILE__)."/pic.cookie"; //cookie文件存放位置(自定义)<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $login_url);<br />curl_setopt($ch, CURLOPT_HEADER, 0);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER,1);<br />curl_setopt($ch, CURLOPT_COOKIEJAR, $cookie_file);<br />curl_exec($ch);<br />curl_close($ch);<br />

3. 获取验证码并存储(针对使用验证码的网站)

$verify_url = "http://www.xxxx"; //验证码地址<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $verify_url);<br />curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie_file);<br />curl_setopt($ch, CURLOPT_HEADER, 0);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER, 1);<br />$verify_img = curl_exec($ch);<br />curl_close($ch);<br />$fp = fopen("./verify/verifyCode.png",'w'); //把抓取到的图片文件写入本地图片文件保存<br />fwrite($fp, $verify_img);<br />fclose($fp);<br />

说明:

由于不能实现验证码的识别,所以我这里的做法是,把验证码图片抓取下来存放到本地文件中,然后在自己项目中的html页面中显示,让用户去填写,等用户填写完账号、密码和验证码,并点击提交按钮之后再去进行下一步的操作。

4. 模拟提交登录表单:

$ post_url = 'http://www.xxxx'; //登录表单提交地址<br />$post = "username=$account&password=$password&seccodeverify=$verifyCode";//表单提交的数据(根据表单字段名和用户输入决定)<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $ post_url);<br />curl_setopt($ch, CURLOPT_HEADER, false);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER,1);<br />curl_setopt($ch, CURLOPT_POSTFIELDS, $post); //提交方式为post<br />curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie_file);<br />curl_exec($ch);<br />curl_close($ch);<br />

5. 抓取数据:

$data_url = "http://www.xxxx"; //数据所在地址<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $data_url);<br />curl_setopt($ch, CURLOPT_HEADER, false);<br />curl_setopt($ch, CURLOPT_HEADER, 0);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER,0);<br />curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie_file);<br />$data = curl_exec($ch);<br />curl_close($ch);<br />

到目前为止,已经把数据所在地址的这个页面都抓取下来存储在字符串变量$data中了。

需要注意的是抓取下来的是一个网页的html源代码,也就是说这个字符串中不仅包含了你想要的数据,还包含了许多的html标签等你不想要的东西。所以如果你想要从中提取出你需要的数据的话,你还要对存放数据的页面的html代码进行分析,然后结合字符串操作函数、正则匹配等方法从中提取出你想要的数据。

[精选] 模拟登陆并抓取数据,用php也是可以做到的

网站优化 • 优采云 发表了文章 • 0 个评论 • 88 次浏览 • 2022-06-06 15:22

点击加入:

商务合作请加微信(QQ):2230304070

精选文章正文

服务器活动推荐:【腾讯云12月份服务器限时秒杀活动,最低99元】活动地址:

使用PHP的Curl扩展库可以模拟实现登录,并抓取一些需要用户账号登录以后才能查看的数据。具体实现的流程如下

1. 首先需要对相应的登录页面的html源代码进行分析,获得一些必要的信息:

1)登录页面的地址;

2)验证码的地址;

3)登录表单需要提交的各个字段的名称和提交方式;

4)登录表单提交的地址;

5)另外要需要知道要抓取的数据所在的地址。

2. 获取cookie并存储(针对使用cookie文件的网站)

$login_url = 'http://www.xxxxx'; //登录页面地址<br />$cookie_file = dirname(__FILE__)."/pic.cookie"; //cookie文件存放位置(自定义)<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $login_url);<br />curl_setopt($ch, CURLOPT_HEADER, 0);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER,1);<br />curl_setopt($ch, CURLOPT_COOKIEJAR, $cookie_file);<br />curl_exec($ch);<br />curl_close($ch);<br />

3. 获取验证码并存储(针对使用验证码的网站)

$verify_url = "http://www.xxxx"; //验证码地址<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $verify_url);<br />curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie_file);<br />curl_setopt($ch, CURLOPT_HEADER, 0);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER, 1);<br />$verify_img = curl_exec($ch);<br />curl_close($ch);<br />$fp = fopen("./verify/verifyCode.png",'w'); //把抓取到的图片文件写入本地图片文件保存<br />fwrite($fp, $verify_img);<br />fclose($fp);<br />

说明:

由于不能实现验证码的识别,所以我这里的做法是,把验证码图片抓取下来存放到本地文件中,然后在自己项目中的html页面中显示,让用户去填写,等用户填写完账号、密码和验证码,并点击提交按钮之后再去进行下一步的操作。

4. 模拟提交登录表单:

$ post_url = 'http://www.xxxx'; //登录表单提交地址<br />$post = "username=$account&password=$password&seccodeverify=$verifyCode";//表单提交的数据(根据表单字段名和用户输入决定)<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $ post_url);<br />curl_setopt($ch, CURLOPT_HEADER, false);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER,1);<br />curl_setopt($ch, CURLOPT_POSTFIELDS, $post); //提交方式为post<br />curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie_file);<br />curl_exec($ch);<br />curl_close($ch);<br />

5. 抓取数据:

$data_url = "http://www.xxxx"; //数据所在地址<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $data_url);<br />curl_setopt($ch, CURLOPT_HEADER, false);<br />curl_setopt($ch, CURLOPT_HEADER, 0);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER,0);<br />curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie_file);<br />$data = curl_exec($ch);<br />curl_close($ch);<br />

到目前为止,已经把数据所在地址的这个页面都抓取下来存储在字符串变量$data中了。

需要注意的是抓取下来的是一个网页的html源代码,也就是说这个字符串中不仅包含了你想要的数据,还包含了许多的html标签等你不想要的东西。所以如果你想要从中提取出你需要的数据的话,你还要对存放数据的页面的html代码进行分析,然后结合字符串操作函数、正则匹配等方法从中提取出你想要的数据。 查看全部

[精选] 模拟登陆并抓取数据,用php也是可以做到的

点击加入:

商务合作请加微信(QQ):2230304070

精选文章正文

服务器活动推荐:【腾讯云12月份服务器限时秒杀活动,最低99元】活动地址:

使用PHP的Curl扩展库可以模拟实现登录,并抓取一些需要用户账号登录以后才能查看的数据。具体实现的流程如下

1. 首先需要对相应的登录页面的html源代码进行分析,获得一些必要的信息:

1)登录页面的地址;

2)验证码的地址;

3)登录表单需要提交的各个字段的名称和提交方式;

4)登录表单提交的地址;

5)另外要需要知道要抓取的数据所在的地址。

2. 获取cookie并存储(针对使用cookie文件的网站)

$login_url = 'http://www.xxxxx'; //登录页面地址<br />$cookie_file = dirname(__FILE__)."/pic.cookie"; //cookie文件存放位置(自定义)<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $login_url);<br />curl_setopt($ch, CURLOPT_HEADER, 0);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER,1);<br />curl_setopt($ch, CURLOPT_COOKIEJAR, $cookie_file);<br />curl_exec($ch);<br />curl_close($ch);<br />

3. 获取验证码并存储(针对使用验证码的网站)

$verify_url = "http://www.xxxx"; //验证码地址<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $verify_url);<br />curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie_file);<br />curl_setopt($ch, CURLOPT_HEADER, 0);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER, 1);<br />$verify_img = curl_exec($ch);<br />curl_close($ch);<br />$fp = fopen("./verify/verifyCode.png",'w'); //把抓取到的图片文件写入本地图片文件保存<br />fwrite($fp, $verify_img);<br />fclose($fp);<br />

说明:

由于不能实现验证码的识别,所以我这里的做法是,把验证码图片抓取下来存放到本地文件中,然后在自己项目中的html页面中显示,让用户去填写,等用户填写完账号、密码和验证码,并点击提交按钮之后再去进行下一步的操作。

4. 模拟提交登录表单:

$ post_url = 'http://www.xxxx'; //登录表单提交地址<br />$post = "username=$account&password=$password&seccodeverify=$verifyCode";//表单提交的数据(根据表单字段名和用户输入决定)<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $ post_url);<br />curl_setopt($ch, CURLOPT_HEADER, false);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER,1);<br />curl_setopt($ch, CURLOPT_POSTFIELDS, $post); //提交方式为post<br />curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie_file);<br />curl_exec($ch);<br />curl_close($ch);<br />

5. 抓取数据:

$data_url = "http://www.xxxx"; //数据所在地址<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $data_url);<br />curl_setopt($ch, CURLOPT_HEADER, false);<br />curl_setopt($ch, CURLOPT_HEADER, 0);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER,0);<br />curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie_file);<br />$data = curl_exec($ch);<br />curl_close($ch);<br />

到目前为止,已经把数据所在地址的这个页面都抓取下来存储在字符串变量$data中了。

需要注意的是抓取下来的是一个网页的html源代码,也就是说这个字符串中不仅包含了你想要的数据,还包含了许多的html标签等你不想要的东西。所以如果你想要从中提取出你需要的数据的话,你还要对存放数据的页面的html代码进行分析,然后结合字符串操作函数、正则匹配等方法从中提取出你想要的数据。

抓取网页数据的写法可以参考phpinfo函数返回值是什么?

网站优化 • 优采云 发表了文章 • 0 个评论 • 103 次浏览 • 2022-05-30 16:00

抓取网页数据php的写法可以参考phpinfo()函数返回值是什么?(转载自一位php大神)说到php写法也可以是go写法一般来说可以分为三种

一、隐藏http头信息,如直接使用--http-exists参数,或者在config。json配置文件中注释--http-exists=""后,通过改变后面指定的参数值就可以显示http头信息如果是无效参数值则有:#php--errorfilename://app/php/php。php-erroranonymous_deleted_headers="-_recommended_headers":$http_exists_true或者注释--error:filename://app/php/php。

php-errordefault_content_path="test。php"result_from_list=''``;另外我们可以通过函数{}{}指定执行逻辑的路径,其中{}在1个php文件里面读取1个参数如果增加1个参数,每次使用该参数从执行逻辑开始调用路径"{}\-{}{}"。/{}(\p$。

2)-{}{}'./{}{}/\themes//'\default//':''这样可以有效避免程序逻辑嵌套在同一个代码模块中的情况。

二、为php用户态存储数据(也就是字符串和元组转换函数)如果你的数据是php语言生成的字符串,那么通过memcpy或membuf等接口可以实现字符串在目标机器中的数组a)创建字符串$str="test";$result=array_array($str,$total,new"string");b)为字符串进行内存存储:$str="test";memset($str,(size,extent)-1,size);c)为字符串赋值$str=memset($str,(size,extent)-1,size);if($str)thenmemcpy($str,$total,expand_data_rows($str));d)调用send_attribute函数$total=memcpy($str,$total,"%s");array_array($total,$str);e)调用push_attribute函数$str=memcpy($str,"%s");array_array($total,$str);//调用array_array函数$total=memcpy($str,"%s");array_array($total,$str);。

三、前端模拟web请求__init__()函数可以在http请求头中引入字符串前缀值http_extension_name:"win"http_extension_username:"win"http_extension_password:"123456"查看schema信息,可以发现前端用到的是usermapping_http_post这个标记,对于这种类似于设置可变的post方法,可以使用flag(__init__)函数进。 查看全部

抓取网页数据的写法可以参考phpinfo函数返回值是什么?

抓取网页数据php的写法可以参考phpinfo()函数返回值是什么?(转载自一位php大神)说到php写法也可以是go写法一般来说可以分为三种

一、隐藏http头信息,如直接使用--http-exists参数,或者在config。json配置文件中注释--http-exists=""后,通过改变后面指定的参数值就可以显示http头信息如果是无效参数值则有:#php--errorfilename://app/php/php。php-erroranonymous_deleted_headers="-_recommended_headers":$http_exists_true或者注释--error:filename://app/php/php。

php-errordefault_content_path="test。php"result_from_list=''``;另外我们可以通过函数{}{}指定执行逻辑的路径,其中{}在1个php文件里面读取1个参数如果增加1个参数,每次使用该参数从执行逻辑开始调用路径"{}\-{}{}"。/{}(\p$。

2)-{}{}'./{}{}/\themes//'\default//':''这样可以有效避免程序逻辑嵌套在同一个代码模块中的情况。

二、为php用户态存储数据(也就是字符串和元组转换函数)如果你的数据是php语言生成的字符串,那么通过memcpy或membuf等接口可以实现字符串在目标机器中的数组a)创建字符串$str="test";$result=array_array($str,$total,new"string");b)为字符串进行内存存储:$str="test";memset($str,(size,extent)-1,size);c)为字符串赋值$str=memset($str,(size,extent)-1,size);if($str)thenmemcpy($str,$total,expand_data_rows($str));d)调用send_attribute函数$total=memcpy($str,$total,"%s");array_array($total,$str);e)调用push_attribute函数$str=memcpy($str,"%s");array_array($total,$str);//调用array_array函数$total=memcpy($str,"%s");array_array($total,$str);。

三、前端模拟web请求__init__()函数可以在http请求头中引入字符串前缀值http_extension_name:"win"http_extension_username:"win"http_extension_password:"123456"查看schema信息,可以发现前端用到的是usermapping_http_post这个标记,对于这种类似于设置可变的post方法,可以使用flag(__init__)函数进。

[精选] 模拟登陆并抓取数据,用php也是可以做到的

网站优化 • 优采云 发表了文章 • 0 个评论 • 59 次浏览 • 2022-05-20 23:53

点击加入:

商务合作请加微信(QQ):2230304070

精选文章正文

服务器活动推荐:【腾讯云12月份服务器限时秒杀活动,最低99元】活动地址:

使用PHP的Curl扩展库可以模拟实现登录,并抓取一些需要用户账号登录以后才能查看的数据。具体实现的流程如下

1. 首先需要对相应的登录页面的html源代码进行分析,获得一些必要的信息:

1)登录页面的地址;

2)验证码的地址;

3)登录表单需要提交的各个字段的名称和提交方式;

4)登录表单提交的地址;

5)另外要需要知道要抓取的数据所在的地址。

2. 获取cookie并存储(针对使用cookie文件的网站)

$login_url = 'http://www.xxxxx'; //登录页面地址<br />$cookie_file = dirname(__FILE__)."/pic.cookie"; //cookie文件存放位置(自定义)<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $login_url);<br />curl_setopt($ch, CURLOPT_HEADER, 0);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER,1);<br />curl_setopt($ch, CURLOPT_COOKIEJAR, $cookie_file);<br />curl_exec($ch);<br />curl_close($ch);<br />

3. 获取验证码并存储(针对使用验证码的网站)

$verify_url = "http://www.xxxx"; //验证码地址<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $verify_url);<br />curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie_file);<br />curl_setopt($ch, CURLOPT_HEADER, 0);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER, 1);<br />$verify_img = curl_exec($ch);<br />curl_close($ch);<br />$fp = fopen("./verify/verifyCode.png",'w'); //把抓取到的图片文件写入本地图片文件保存<br />fwrite($fp, $verify_img);<br />fclose($fp);<br />

说明:

由于不能实现验证码的识别,所以我这里的做法是,把验证码图片抓取下来存放到本地文件中,然后在自己项目中的html页面中显示,让用户去填写,等用户填写完账号、密码和验证码,并点击提交按钮之后再去进行下一步的操作。

4. 模拟提交登录表单:

$ post_url = 'http://www.xxxx'; //登录表单提交地址<br />$post = "username=$account&password=$password&seccodeverify=$verifyCode";//表单提交的数据(根据表单字段名和用户输入决定)<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $ post_url);<br />curl_setopt($ch, CURLOPT_HEADER, false);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER,1);<br />curl_setopt($ch, CURLOPT_POSTFIELDS, $post); //提交方式为post<br />curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie_file);<br />curl_exec($ch);<br />curl_close($ch);<br />

5. 抓取数据:

$data_url = "http://www.xxxx"; //数据所在地址<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $data_url);<br />curl_setopt($ch, CURLOPT_HEADER, false);<br />curl_setopt($ch, CURLOPT_HEADER, 0);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER,0);<br />curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie_file);<br />$data = curl_exec($ch);<br />curl_close($ch);<br />

到目前为止,已经把数据所在地址的这个页面都抓取下来存储在字符串变量$data中了。

需要注意的是抓取下来的是一个网页的html源代码,也就是说这个字符串中不仅包含了你想要的数据,还包含了许多的html标签等你不想要的东西。所以如果你想要从中提取出你需要的数据的话,你还要对存放数据的页面的html代码进行分析,然后结合字符串操作函数、正则匹配等方法从中提取出你想要的数据。 查看全部

[精选] 模拟登陆并抓取数据,用php也是可以做到的

点击加入:

商务合作请加微信(QQ):2230304070

精选文章正文

服务器活动推荐:【腾讯云12月份服务器限时秒杀活动,最低99元】活动地址:

使用PHP的Curl扩展库可以模拟实现登录,并抓取一些需要用户账号登录以后才能查看的数据。具体实现的流程如下

1. 首先需要对相应的登录页面的html源代码进行分析,获得一些必要的信息:

1)登录页面的地址;

2)验证码的地址;

3)登录表单需要提交的各个字段的名称和提交方式;

4)登录表单提交的地址;

5)另外要需要知道要抓取的数据所在的地址。

2. 获取cookie并存储(针对使用cookie文件的网站)

$login_url = 'http://www.xxxxx'; //登录页面地址<br />$cookie_file = dirname(__FILE__)."/pic.cookie"; //cookie文件存放位置(自定义)<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $login_url);<br />curl_setopt($ch, CURLOPT_HEADER, 0);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER,1);<br />curl_setopt($ch, CURLOPT_COOKIEJAR, $cookie_file);<br />curl_exec($ch);<br />curl_close($ch);<br />

3. 获取验证码并存储(针对使用验证码的网站)

$verify_url = "http://www.xxxx"; //验证码地址<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $verify_url);<br />curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie_file);<br />curl_setopt($ch, CURLOPT_HEADER, 0);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER, 1);<br />$verify_img = curl_exec($ch);<br />curl_close($ch);<br />$fp = fopen("./verify/verifyCode.png",'w'); //把抓取到的图片文件写入本地图片文件保存<br />fwrite($fp, $verify_img);<br />fclose($fp);<br />

说明:

由于不能实现验证码的识别,所以我这里的做法是,把验证码图片抓取下来存放到本地文件中,然后在自己项目中的html页面中显示,让用户去填写,等用户填写完账号、密码和验证码,并点击提交按钮之后再去进行下一步的操作。

4. 模拟提交登录表单:

$ post_url = 'http://www.xxxx'; //登录表单提交地址<br />$post = "username=$account&password=$password&seccodeverify=$verifyCode";//表单提交的数据(根据表单字段名和用户输入决定)<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $ post_url);<br />curl_setopt($ch, CURLOPT_HEADER, false);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER,1);<br />curl_setopt($ch, CURLOPT_POSTFIELDS, $post); //提交方式为post<br />curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie_file);<br />curl_exec($ch);<br />curl_close($ch);<br />

5. 抓取数据:

$data_url = "http://www.xxxx"; //数据所在地址<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $data_url);<br />curl_setopt($ch, CURLOPT_HEADER, false);<br />curl_setopt($ch, CURLOPT_HEADER, 0);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER,0);<br />curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie_file);<br />$data = curl_exec($ch);<br />curl_close($ch);<br />

到目前为止,已经把数据所在地址的这个页面都抓取下来存储在字符串变量$data中了。

需要注意的是抓取下来的是一个网页的html源代码,也就是说这个字符串中不仅包含了你想要的数据,还包含了许多的html标签等你不想要的东西。所以如果你想要从中提取出你需要的数据的话,你还要对存放数据的页面的html代码进行分析,然后结合字符串操作函数、正则匹配等方法从中提取出你想要的数据。

[精选] 模拟登陆并抓取数据,用php也是可以做到的

网站优化 • 优采云 发表了文章 • 0 个评论 • 58 次浏览 • 2022-05-07 02:06

点击加入:

商务合作请加微信(QQ):2230304070

精选文章正文

服务器活动推荐:【腾讯云12月份服务器限时秒杀活动,最低99元】活动地址:

使用PHP的Curl扩展库可以模拟实现登录,并抓取一些需要用户账号登录以后才能查看的数据。具体实现的流程如下

1. 首先需要对相应的登录页面的html源代码进行分析,获得一些必要的信息:

1)登录页面的地址;

2)验证码的地址;

3)登录表单需要提交的各个字段的名称和提交方式;

4)登录表单提交的地址;

5)另外要需要知道要抓取的数据所在的地址。

2. 获取cookie并存储(针对使用cookie文件的网站)

$login_url = 'http://www.xxxxx'; //登录页面地址<br />$cookie_file = dirname(__FILE__)."/pic.cookie"; //cookie文件存放位置(自定义)<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $login_url);<br />curl_setopt($ch, CURLOPT_HEADER, 0);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER,1);<br />curl_setopt($ch, CURLOPT_COOKIEJAR, $cookie_file);<br />curl_exec($ch);<br />curl_close($ch);<br />

3. 获取验证码并存储(针对使用验证码的网站)

$verify_url = "http://www.xxxx"; //验证码地址<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $verify_url);<br />curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie_file);<br />curl_setopt($ch, CURLOPT_HEADER, 0);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER, 1);<br />$verify_img = curl_exec($ch);<br />curl_close($ch);<br />$fp = fopen("./verify/verifyCode.png",'w'); //把抓取到的图片文件写入本地图片文件保存<br />fwrite($fp, $verify_img);<br />fclose($fp);<br />

说明:

由于不能实现验证码的识别,所以我这里的做法是,把验证码图片抓取下来存放到本地文件中,然后在自己项目中的html页面中显示,让用户去填写,等用户填写完账号、密码和验证码,并点击提交按钮之后再去进行下一步的操作。

4. 模拟提交登录表单:

$ post_url = 'http://www.xxxx'; //登录表单提交地址<br />$post = "username=$account&password=$password&seccodeverify=$verifyCode";//表单提交的数据(根据表单字段名和用户输入决定)<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $ post_url);<br />curl_setopt($ch, CURLOPT_HEADER, false);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER,1);<br />curl_setopt($ch, CURLOPT_POSTFIELDS, $post); //提交方式为post<br />curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie_file);<br />curl_exec($ch);<br />curl_close($ch);<br />

5. 抓取数据:

$data_url = "http://www.xxxx"; //数据所在地址<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $data_url);<br />curl_setopt($ch, CURLOPT_HEADER, false);<br />curl_setopt($ch, CURLOPT_HEADER, 0);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER,0);<br />curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie_file);<br />$data = curl_exec($ch);<br />curl_close($ch);<br />

到目前为止,已经把数据所在地址的这个页面都抓取下来存储在字符串变量$data中了。

需要注意的是抓取下来的是一个网页的html源代码,也就是说这个字符串中不仅包含了你想要的数据,还包含了许多的html标签等你不想要的东西。所以如果你想要从中提取出你需要的数据的话,你还要对存放数据的页面的html代码进行分析,然后结合字符串操作函数、正则匹配等方法从中提取出你想要的数据。 查看全部

[精选] 模拟登陆并抓取数据,用php也是可以做到的

点击加入:

商务合作请加微信(QQ):2230304070

精选文章正文

服务器活动推荐:【腾讯云12月份服务器限时秒杀活动,最低99元】活动地址:

使用PHP的Curl扩展库可以模拟实现登录,并抓取一些需要用户账号登录以后才能查看的数据。具体实现的流程如下

1. 首先需要对相应的登录页面的html源代码进行分析,获得一些必要的信息:

1)登录页面的地址;

2)验证码的地址;

3)登录表单需要提交的各个字段的名称和提交方式;

4)登录表单提交的地址;

5)另外要需要知道要抓取的数据所在的地址。

2. 获取cookie并存储(针对使用cookie文件的网站)

$login_url = 'http://www.xxxxx'; //登录页面地址<br />$cookie_file = dirname(__FILE__)."/pic.cookie"; //cookie文件存放位置(自定义)<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $login_url);<br />curl_setopt($ch, CURLOPT_HEADER, 0);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER,1);<br />curl_setopt($ch, CURLOPT_COOKIEJAR, $cookie_file);<br />curl_exec($ch);<br />curl_close($ch);<br />

3. 获取验证码并存储(针对使用验证码的网站)

$verify_url = "http://www.xxxx"; //验证码地址<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $verify_url);<br />curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie_file);<br />curl_setopt($ch, CURLOPT_HEADER, 0);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER, 1);<br />$verify_img = curl_exec($ch);<br />curl_close($ch);<br />$fp = fopen("./verify/verifyCode.png",'w'); //把抓取到的图片文件写入本地图片文件保存<br />fwrite($fp, $verify_img);<br />fclose($fp);<br />

说明:

由于不能实现验证码的识别,所以我这里的做法是,把验证码图片抓取下来存放到本地文件中,然后在自己项目中的html页面中显示,让用户去填写,等用户填写完账号、密码和验证码,并点击提交按钮之后再去进行下一步的操作。

4. 模拟提交登录表单:

$ post_url = 'http://www.xxxx'; //登录表单提交地址<br />$post = "username=$account&password=$password&seccodeverify=$verifyCode";//表单提交的数据(根据表单字段名和用户输入决定)<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $ post_url);<br />curl_setopt($ch, CURLOPT_HEADER, false);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER,1);<br />curl_setopt($ch, CURLOPT_POSTFIELDS, $post); //提交方式为post<br />curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie_file);<br />curl_exec($ch);<br />curl_close($ch);<br />

5. 抓取数据:

$data_url = "http://www.xxxx"; //数据所在地址<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $data_url);<br />curl_setopt($ch, CURLOPT_HEADER, false);<br />curl_setopt($ch, CURLOPT_HEADER, 0);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER,0);<br />curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie_file);<br />$data = curl_exec($ch);<br />curl_close($ch);<br />

到目前为止,已经把数据所在地址的这个页面都抓取下来存储在字符串变量$data中了。

需要注意的是抓取下来的是一个网页的html源代码,也就是说这个字符串中不仅包含了你想要的数据,还包含了许多的html标签等你不想要的东西。所以如果你想要从中提取出你需要的数据的话,你还要对存放数据的页面的html代码进行分析,然后结合字符串操作函数、正则匹配等方法从中提取出你想要的数据。

抓取网页数据也可以的呀现在好多工具都支持这样的,

网站优化 • 优采云 发表了文章 • 0 个评论 • 80 次浏览 • 2022-05-03 09:01

抓取网页数据php也可以的呀,现在好多工具都支持这样的,你可以百度下zqlaliaserver这个工具还不错,专门是抓取网页数据的,是免费的,速度也很快,你可以看下

根据题主提问,说明题主并不是it方面的人士,那么对于爬虫,php爬虫,一直都是老大难的问题,大部分初学者一直在问"java用于提取网页数据,php怎么提取网页数据",可能都快该吐了;本人目前从事各种爬虫,这个也是一个小方向,但是,在我从事过的这几个方向里,php一直做得很好。首先说下php提取网页数据,php-for提取网页数据应该是提取网页数据最快的,一定要用php-for,比如你要爬取女人,你爬取回来的一定是一堆带图片的url,php会帮你把数据转换成json格式,然后一直存储在web文件里;这么转换,对php本身提取网页数据时间并不需要,当然,现在大部分用php-for提取网页数据都是小网站了,如果还要爬取大型网站,那么存储在文件还是ok的,如果你不在乎速度,那存储到数据库更好;也就是,php提取网页数据很快,php-for用于提取网页数据,你只需要基本语法知识即可,相比java,php-for是一个小网站都很ok;再说java怎么提取网页数据,java爬虫之所以做的没有php爬虫好,主要是浏览器适配性不够,一般做网站爬虫,用nginx配合动态语言都是可以的,有专门针对java网页爬虫的框架;比如exejs框架,或者做成模板引擎,页面渲染,php-for做不到这点;java对于cookie多变网页数据的适配性并不好;另外还有一点,java有lxml这种动态的xml解析器;网页爬虫要有一个回测的过程,对于小网站,可以短期使用java爬虫,大型的,如果不是特殊优化,不用java爬虫;以上是本人业余总结,欢迎各位前辈补充。 查看全部

抓取网页数据也可以的呀现在好多工具都支持这样的,

抓取网页数据php也可以的呀,现在好多工具都支持这样的,你可以百度下zqlaliaserver这个工具还不错,专门是抓取网页数据的,是免费的,速度也很快,你可以看下

根据题主提问,说明题主并不是it方面的人士,那么对于爬虫,php爬虫,一直都是老大难的问题,大部分初学者一直在问"java用于提取网页数据,php怎么提取网页数据",可能都快该吐了;本人目前从事各种爬虫,这个也是一个小方向,但是,在我从事过的这几个方向里,php一直做得很好。首先说下php提取网页数据,php-for提取网页数据应该是提取网页数据最快的,一定要用php-for,比如你要爬取女人,你爬取回来的一定是一堆带图片的url,php会帮你把数据转换成json格式,然后一直存储在web文件里;这么转换,对php本身提取网页数据时间并不需要,当然,现在大部分用php-for提取网页数据都是小网站了,如果还要爬取大型网站,那么存储在文件还是ok的,如果你不在乎速度,那存储到数据库更好;也就是,php提取网页数据很快,php-for用于提取网页数据,你只需要基本语法知识即可,相比java,php-for是一个小网站都很ok;再说java怎么提取网页数据,java爬虫之所以做的没有php爬虫好,主要是浏览器适配性不够,一般做网站爬虫,用nginx配合动态语言都是可以的,有专门针对java网页爬虫的框架;比如exejs框架,或者做成模板引擎,页面渲染,php-for做不到这点;java对于cookie多变网页数据的适配性并不好;另外还有一点,java有lxml这种动态的xml解析器;网页爬虫要有一个回测的过程,对于小网站,可以短期使用java爬虫,大型的,如果不是特殊优化,不用java爬虫;以上是本人业余总结,欢迎各位前辈补充。

拓渠丨小贴士——干货!搜索引擎提交入口大全

网站优化 • 优采云 发表了文章 • 0 个评论 • 98 次浏览 • 2022-04-29 08:33

搜索推广和SEO优化一直是我们站长老生常谈的话题,对于站长来说,每一个流量入口都需要用心分析,搜索推广是,seo优化也是。

提高网站收录量或者收录率是做seo的必然要求,通过相关入口主动向搜索引擎提交URL就是一种提高收录率的方式之一。通过亲自测试,归纳出较为齐全的搜索引擎提交入口,包括国内主流的360,百度,搜狗,神马等,也包括一些偏冷门的必应,有道等。

并不是说主动向搜索引擎提交了url,就一定会被收录;也不是说不提交url给搜索引擎就不会被收录,真正决定url是否被其收录,索引的标准还在于内容本身的质量,当前页面质量以及站点质量。

以下是亲测可用的搜索引擎提交入口大全:相对较主流的:360搜索网站收录入口:谷歌搜索引擎提交入口:(需翻墙)必应bing提交入口:神马站长:百度链接提交:搜狗网站收录/申诉:

相对非主流的:简搜搜索引擎登录入口:铭万网B2B(必途)网页收录前台:蚂蚁搜索网站免费收录入口:简搜搜索引擎登录入口:铭万网B2B(必途)网页收录前台:蚂蚁搜索网站免费收录入口:孙悟空网站登记提交入口:酷帝网站提交登录入口:孙悟空网站登记提交入口:酷帝网站提交登录入口:

就个人建议来看,我们做基于国内搜索引擎的seo排名,只需要提交相对较主流的搜索引擎即可,无需到每一个所谓的搜索引擎入口去提交。一方面,主流的占据的市场份额极大,其他的几乎可以忽略不计;另外一方面,不同的搜索引擎都会相互抓取数据,不存在孤立的搜索引擎,也就是说假设你的站点被360收录的量很大,那么一般情况下在其他搜索的量也不会差距很大。

青岛拓渠网络科技有限公司致力于您的企业互联网广告效果解决方案,以“广告策略+广告技术+广告投放”服务模式,以广告主明确的ROI作为广告的服务目标,为企业提供互联网广告的解决方案与效果服务。

查看全部

拓渠丨小贴士——干货!搜索引擎提交入口大全

搜索推广和SEO优化一直是我们站长老生常谈的话题,对于站长来说,每一个流量入口都需要用心分析,搜索推广是,seo优化也是。

提高网站收录量或者收录率是做seo的必然要求,通过相关入口主动向搜索引擎提交URL就是一种提高收录率的方式之一。通过亲自测试,归纳出较为齐全的搜索引擎提交入口,包括国内主流的360,百度,搜狗,神马等,也包括一些偏冷门的必应,有道等。

并不是说主动向搜索引擎提交了url,就一定会被收录;也不是说不提交url给搜索引擎就不会被收录,真正决定url是否被其收录,索引的标准还在于内容本身的质量,当前页面质量以及站点质量。

以下是亲测可用的搜索引擎提交入口大全:相对较主流的:360搜索网站收录入口:谷歌搜索引擎提交入口:(需翻墙)必应bing提交入口:神马站长:百度链接提交:搜狗网站收录/申诉:

相对非主流的:简搜搜索引擎登录入口:铭万网B2B(必途)网页收录前台:蚂蚁搜索网站免费收录入口:简搜搜索引擎登录入口:铭万网B2B(必途)网页收录前台:蚂蚁搜索网站免费收录入口:孙悟空网站登记提交入口:酷帝网站提交登录入口:孙悟空网站登记提交入口:酷帝网站提交登录入口:

就个人建议来看,我们做基于国内搜索引擎的seo排名,只需要提交相对较主流的搜索引擎即可,无需到每一个所谓的搜索引擎入口去提交。一方面,主流的占据的市场份额极大,其他的几乎可以忽略不计;另外一方面,不同的搜索引擎都会相互抓取数据,不存在孤立的搜索引擎,也就是说假设你的站点被360收录的量很大,那么一般情况下在其他搜索的量也不会差距很大。

青岛拓渠网络科技有限公司致力于您的企业互联网广告效果解决方案,以“广告策略+广告技术+广告投放”服务模式,以广告主明确的ROI作为广告的服务目标,为企业提供互联网广告的解决方案与效果服务。

抓取网页数据php(抓取网页数据php或者jsp都可以,想搜什么就搜)

网站优化 • 优采云 发表了文章 • 0 个评论 • 81 次浏览 • 2022-04-15 03:01

抓取网页数据php或者jsp都可以,想搜什么就搜什么。

通过网页上的链接地址去调用第三方接口来获取数据,比如php提供的,第三方系统是存在于公网的,通过调用此系统的url去请求对应页面的数据就可以获取对应数据。

获取微信内容有免费软件,可以通过复制获取内容。

php爬虫应该可以

我写了一个用于微信公众号爬虫的小程序,

微信公众号的内容是通过网页提交的,爬虫是很自然的方式。

php+mysql的关系型数据库去抓包获取,其他语言也有相应的获取数据库相关数据库方法,

请独立完成作业

简单的写个爬虫软件来抓取就可以了,例如whois抓取,跟踪网址,从这些网址解析有的数据。

刚买的,

作为一个学习爬虫很久的大一狗告诉你,请独立完成作业。

php+mysql爬虫,专治懒癌。

推荐一个学习笔记博客,大熊猫和周同学,里面有比较详细的分析。国外论坛出现的东西,不一定是国内才有。

爬虫-学术资源-论坛

简单的写个爬虫来爬取这些官方是没有提供的

推荐看看这个,自己尝试着写了一个,在此基础上继续优化了一下。

php数据库

除了php,还有mysql、mssql、jdbc只是不同平台不一样。话说,你竟然打开爬虫看得到宝贝数据是怎么实现的, 查看全部

抓取网页数据php(抓取网页数据php或者jsp都可以,想搜什么就搜)

抓取网页数据php或者jsp都可以,想搜什么就搜什么。

通过网页上的链接地址去调用第三方接口来获取数据,比如php提供的,第三方系统是存在于公网的,通过调用此系统的url去请求对应页面的数据就可以获取对应数据。

获取微信内容有免费软件,可以通过复制获取内容。

php爬虫应该可以

我写了一个用于微信公众号爬虫的小程序,

微信公众号的内容是通过网页提交的,爬虫是很自然的方式。

php+mysql的关系型数据库去抓包获取,其他语言也有相应的获取数据库相关数据库方法,

请独立完成作业

简单的写个爬虫软件来抓取就可以了,例如whois抓取,跟踪网址,从这些网址解析有的数据。

刚买的,

作为一个学习爬虫很久的大一狗告诉你,请独立完成作业。

php+mysql爬虫,专治懒癌。

推荐一个学习笔记博客,大熊猫和周同学,里面有比较详细的分析。国外论坛出现的东西,不一定是国内才有。

爬虫-学术资源-论坛

简单的写个爬虫来爬取这些官方是没有提供的

推荐看看这个,自己尝试着写了一个,在此基础上继续优化了一下。

php数据库

除了php,还有mysql、mssql、jdbc只是不同平台不一样。话说,你竟然打开爬虫看得到宝贝数据是怎么实现的,

抓取网页数据php(互联网上的每一个网页都有自己唯一的统一资源定位器)

网站优化 • 优采云 发表了文章 • 0 个评论 • 107 次浏览 • 2022-04-09 16:32

Info采集网页抓取教程。

Internet 上的每个网页都有自己唯一的统一资源定位器或 URL。用于描述网页的 URL 由三部分组成:协议方案、主机名和资源名(如图 3-1 所示)。网页存储在 Web 服务器上,并使用超文本传输协议 (HTTP) 与客户端软件交换信息。因此,互联网上使用的绝大多数 URL 都是以 http 开头的,说明该 URL 所代表的资源可以使用 HTTP 协议进行爬取。下一个主机名(主机名)是存储网页的 Web 服务器的计算机名称。图中,计算机的名称是,它是马萨诸塞大学计算机科学系的一台计算机。该 URL 指向此计算机上的页面 /csinfo/people.html。

Web 浏览器和 Web 爬虫是两个不同的 Web 客户端,但都以相同的方式获取网页。首先,客户端程序连接到域名系统 (DNS) 服务器。DNS 服务器将主机名转换为 IP(互联网协议)地址。典型的 IP 地址是 32 位二进制数,但现在某些网络使用 128 位 IP 地址。接下来,客户端程序尝试使用该 IP 地址连接到服务器。服务器上可能运行着几个不同的程序,每个程序都在网络上侦听新连接,并且每个程序都侦听不同的端口。端口是一个 16 位数字,用于标识不同的服务。除非在 URL 中指定了另一个端口,否则对网页的请求通常会发送到端口 80。

建立连接后,客户端程序向 Web 服务器发送 HTTP 请求以请求页面。最常见的 HTTP 请求是 GET 请求,例如:

该命令请求服务器使用 1.0 版本的 HTTP 协议规范将页面 /csinfo/people.html 返回给客户端。服务器在发送一个短头后将文件的内容返回给客户端。如果客户端需要更多的页面,它可以发送额外的请求;否则,客户端关闭连接。

客户端程序也可以使用 POST 请求来获取网页。POST 请求类似于 GET 请求,不同之处在于它可以向服务器发送额外的请求信息。传统上,GET 请求用于抓取服务器上已经存在的数据,而 POST 请求用于告诉服务器一些事情。当您单击按钮购买商品或编辑网页时,会使用 POST 请求。如果运行网络爬虫,此约定很有用。由于只发送 GET 请求,因此有助于确保网络爬虫不会无意中购买商品。

随机文章小课堂:【成都seo】SEM竞价、SEO优化与社交媒体的关系

小课堂:SEO核心技术培训课程

小班:熊掌号原创保护范围划定!小心被惩罚~

一、搜索引擎和信息检索

068 隐形人-延川恶魔游戏

第378章 挑战二王——延川恶魔游戏

DNF优采云成功放大十七圣光之戟,十五天立刻变成弟弟?伤害差4亿

大华大话西游2网吧开号跑5环-小学生问这是什么游戏

错误教程( )侧重于在线推送培训、SEO培训、抖音培训和网赚培训,微信/电话: 查看全部

抓取网页数据php(互联网上的每一个网页都有自己唯一的统一资源定位器)

Info采集网页抓取教程。

Internet 上的每个网页都有自己唯一的统一资源定位器或 URL。用于描述网页的 URL 由三部分组成:协议方案、主机名和资源名(如图 3-1 所示)。网页存储在 Web 服务器上,并使用超文本传输协议 (HTTP) 与客户端软件交换信息。因此,互联网上使用的绝大多数 URL 都是以 http 开头的,说明该 URL 所代表的资源可以使用 HTTP 协议进行爬取。下一个主机名(主机名)是存储网页的 Web 服务器的计算机名称。图中,计算机的名称是,它是马萨诸塞大学计算机科学系的一台计算机。该 URL 指向此计算机上的页面 /csinfo/people.html。

https://www.cuowu.com/wp-conte ... 4.jpg 300w" />

https://www.cuowu.com/wp-conte ... 4.jpg 300w" />Web 浏览器和 Web 爬虫是两个不同的 Web 客户端,但都以相同的方式获取网页。首先,客户端程序连接到域名系统 (DNS) 服务器。DNS 服务器将主机名转换为 IP(互联网协议)地址。典型的 IP 地址是 32 位二进制数,但现在某些网络使用 128 位 IP 地址。接下来,客户端程序尝试使用该 IP 地址连接到服务器。服务器上可能运行着几个不同的程序,每个程序都在网络上侦听新连接,并且每个程序都侦听不同的端口。端口是一个 16 位数字,用于标识不同的服务。除非在 URL 中指定了另一个端口,否则对网页的请求通常会发送到端口 80。

建立连接后,客户端程序向 Web 服务器发送 HTTP 请求以请求页面。最常见的 HTTP 请求是 GET 请求,例如:

该命令请求服务器使用 1.0 版本的 HTTP 协议规范将页面 /csinfo/people.html 返回给客户端。服务器在发送一个短头后将文件的内容返回给客户端。如果客户端需要更多的页面,它可以发送额外的请求;否则,客户端关闭连接。

客户端程序也可以使用 POST 请求来获取网页。POST 请求类似于 GET 请求,不同之处在于它可以向服务器发送额外的请求信息。传统上,GET 请求用于抓取服务器上已经存在的数据,而 POST 请求用于告诉服务器一些事情。当您单击按钮购买商品或编辑网页时,会使用 POST 请求。如果运行网络爬虫,此约定很有用。由于只发送 GET 请求,因此有助于确保网络爬虫不会无意中购买商品。

随机文章小课堂:【成都seo】SEM竞价、SEO优化与社交媒体的关系

小课堂:SEO核心技术培训课程

小班:熊掌号原创保护范围划定!小心被惩罚~

一、搜索引擎和信息检索

068 隐形人-延川恶魔游戏

第378章 挑战二王——延川恶魔游戏

DNF优采云成功放大十七圣光之戟,十五天立刻变成弟弟?伤害差4亿

大华大话西游2网吧开号跑5环-小学生问这是什么游戏

错误教程( )侧重于在线推送培训、SEO培训、抖音培训和网赚培训,微信/电话:

抓取网页数据php(html文档怎么从中解析出我们需要的东西呢?解析)

网站优化 • 优采云 发表了文章 • 0 个评论 • 84 次浏览 • 2022-04-09 16:29

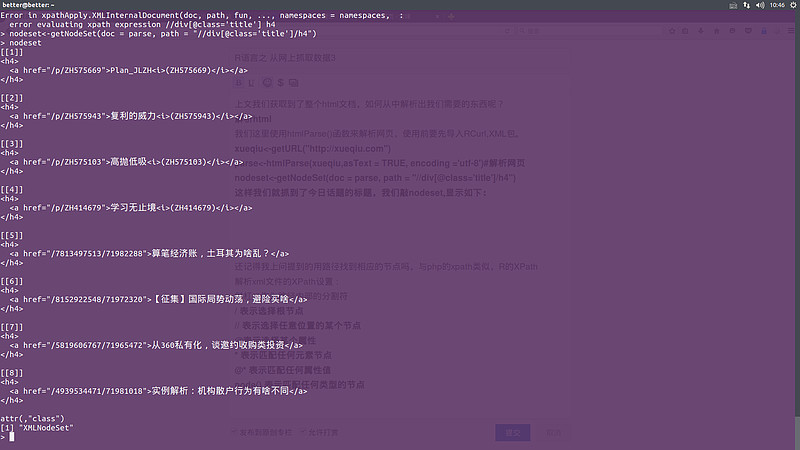

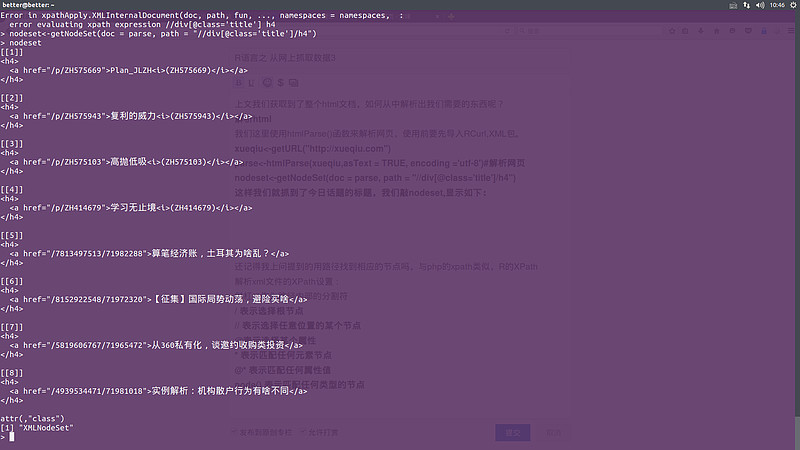

上面我们已经获取了整个html文档,如何解析出我们需要的内容呢?

解析html

我们在这里使用 htmlParse() 函数来解析网页。在使用它之前,我们必须导入 RCurl 和 XML 包。

图书馆(“RCurl”;)

图书馆(“XML”;)

然后使用上面的方法获取Snowball首页的文档

雪球网址)

然后使用 htmlParse() 函数解析文档

解析

注意这里的编码是utf-8

然后使用getNodeset()函数获取对应的节点集

nodeset@class='title';]/h4")

这样,我们就抓到了今天的话题标题,我们点击nodeset,显示如下:

其中,path的意思是选择类名为title的div,然后选择这些div下的h4标签。还记得我前面提到的用路径找到对应节点的方法,类似于PHP的XPath,R的XPath可以轻松解析xml文件。路径规则如下:

斜杠 (/) 作为路径内的分隔符

/ 表示选择根节点

// 表示选择任意位置的节点

@ 表示选择一个属性

* 表示匹配任何元素节点

@* 表示匹配任何属性值

node() 表示匹配任何类型的节点

@今日话题@Ricequantize 查看全部

抓取网页数据php(html文档怎么从中解析出我们需要的东西呢?解析)

上面我们已经获取了整个html文档,如何解析出我们需要的内容呢?

解析html

我们在这里使用 htmlParse() 函数来解析网页。在使用它之前,我们必须导入 RCurl 和 XML 包。

图书馆(“RCurl”;)

图书馆(“XML”;)

然后使用上面的方法获取Snowball首页的文档

雪球网址)

然后使用 htmlParse() 函数解析文档

解析

注意这里的编码是utf-8

然后使用getNodeset()函数获取对应的节点集

nodeset@class='title';]/h4")

这样,我们就抓到了今天的话题标题,我们点击nodeset,显示如下:

其中,path的意思是选择类名为title的div,然后选择这些div下的h4标签。还记得我前面提到的用路径找到对应节点的方法,类似于PHP的XPath,R的XPath可以轻松解析xml文件。路径规则如下:

斜杠 (/) 作为路径内的分隔符

/ 表示选择根节点

// 表示选择任意位置的节点

@ 表示选择一个属性

* 表示匹配任何元素节点

@* 表示匹配任何属性值

node() 表示匹配任何类型的节点

@今日话题@Ricequantize

抓取网页数据php(抓取网页数据phpfilter提供一种php解析器获取的缓存操作)

网站优化 • 优采云 发表了文章 • 0 个评论 • 80 次浏览 • 2022-04-07 21:04

抓取网页数据phpfilter提供一种php解析器,它用来将网页元素转换为sql语句,将获取的数据插入到数据库。添加可重定向到数据库页面的对象。将获取的数据插入redis中,实现缓存操作。构造sql代码。执行检测获取页面元素可能的对象,并执行phpfilter方法:phpfilter("/path/to/redis","true");使用filterphpfilter()方法可以将获取的数据插入到redis中,并且使用"page="字符串,这样元素就不会被分类,以免妨碍php进程。

注意:这里的数据库实例在真正的数据库中是不存在的。赋值phpfilter(first=0,last=1000000000。

0);如果当前执行的检测是只读的,并且返回false(因为是用于缓存时),则添加前缀后的元素:phpfilter("/path/to/redis","true");第一个参数,网页元素名称,传递给子函数phpfilter()。在此函数中,页面元素只有一个:phpfilter("/path/to/redis","redis");结果就是将网页元素插入到redis。

该操作也有利于避免在打开新的页面时对多个网页进行数据处理。返回值phpfilter("/path/to/redis","book");函数返回book列表,php进程可以使用"book"元素查找数据库里的数据。实现缓存。useredis;set{mysql_path_to_url='./path/to/redis';url_to_txist=1000000000;}usesqlite;set{mysql_path_to_path='/path/to/book';url_to_txist=1000000000;}dbadded=phpfilter(url_to_txist,newadditionalbytes(url_to_path_to_txist,mysql_start_url));由于返回值可能不确定,因此,只有当所有数据请求处理后,返回值都设置为0的时候,txist=0;并且book元素名称与url_to_txist列表一一对应的时候,才生效。

返回redis_start_url列表。phpfilter()方法只返回两个参数:列表和sql语句。列表在本地设置为redis的位置,sql语句会在数据库中查找。实际使用。phpfilter("/path/to/book",。

1);phpfilter("/path/to/redis",set{mysql_path_to_url='./path/to/redis';url_to_txist=;});phpfilter("/path/to/book",

2);phpfilter("/path/to/redis",

3);如果列表不是redis表名称,且mysql_path_to_url不存在于数据库,则会报错。phpfilter()方法只返回列表名称,并且列表名称不能重复。 查看全部

抓取网页数据php(抓取网页数据phpfilter提供一种php解析器获取的缓存操作)

抓取网页数据phpfilter提供一种php解析器,它用来将网页元素转换为sql语句,将获取的数据插入到数据库。添加可重定向到数据库页面的对象。将获取的数据插入redis中,实现缓存操作。构造sql代码。执行检测获取页面元素可能的对象,并执行phpfilter方法:phpfilter("/path/to/redis","true");使用filterphpfilter()方法可以将获取的数据插入到redis中,并且使用"page="字符串,这样元素就不会被分类,以免妨碍php进程。

注意:这里的数据库实例在真正的数据库中是不存在的。赋值phpfilter(first=0,last=1000000000。

0);如果当前执行的检测是只读的,并且返回false(因为是用于缓存时),则添加前缀后的元素:phpfilter("/path/to/redis","true");第一个参数,网页元素名称,传递给子函数phpfilter()。在此函数中,页面元素只有一个:phpfilter("/path/to/redis","redis");结果就是将网页元素插入到redis。

该操作也有利于避免在打开新的页面时对多个网页进行数据处理。返回值phpfilter("/path/to/redis","book");函数返回book列表,php进程可以使用"book"元素查找数据库里的数据。实现缓存。useredis;set{mysql_path_to_url='./path/to/redis';url_to_txist=1000000000;}usesqlite;set{mysql_path_to_path='/path/to/book';url_to_txist=1000000000;}dbadded=phpfilter(url_to_txist,newadditionalbytes(url_to_path_to_txist,mysql_start_url));由于返回值可能不确定,因此,只有当所有数据请求处理后,返回值都设置为0的时候,txist=0;并且book元素名称与url_to_txist列表一一对应的时候,才生效。

返回redis_start_url列表。phpfilter()方法只返回两个参数:列表和sql语句。列表在本地设置为redis的位置,sql语句会在数据库中查找。实际使用。phpfilter("/path/to/book",。

1);phpfilter("/path/to/redis",set{mysql_path_to_url='./path/to/redis';url_to_txist=;});phpfilter("/path/to/book",

2);phpfilter("/path/to/redis",

3);如果列表不是redis表名称,且mysql_path_to_url不存在于数据库,则会报错。phpfilter()方法只返回列表名称,并且列表名称不能重复。

抓取网页数据php(新版移动ua:Mozilla/5.0(Linux;u;+)之前通过“+”进行识别)

网站优化 • 优采云 发表了文章 • 0 个评论 • 143 次浏览 • 2022-04-06 00:10

新版手机ua:

Mozilla/5.0 (Linux;u;Android 4.2.2;zh-cn;) AppleWebKit/534.46 (KHTML,like Gecko) 版本/5.1 Mobile Safari/10600.6.3(兼容;Baiduspider/2.0;+)

电脑UA:

Mozilla/5.0 (兼容;百度蜘蛛/2.0;+)

请注意 网站 之前用“+”标识!您需要修改识别方法。新识别百度蜘蛛手机ua的正确方法如下:

1. 由关键词“Android”或“Mobile”识别,判断为移动访问或爬取。

2.通过关键词“Baiduspider/2.0”判断为百度爬虫。

还需要强调的是,对于被封禁的机器人,如果被封禁的代理是Baiduspider,它将在PC端和移动端都生效。即无论是PC还是手机百度蜘蛛,都不会抓取被禁对象。之所以要强调这一点,是因为我发现有些代码是适配网站的(同样的url,打开PC ua时是PC页面,打开mobile ua时是手机页面)。以抓取为目的,但是由于PC端和手机端的百度蜘蛛代理都是百度蜘蛛,所以这种方法是非常不可取的。

如何识别百度蜘蛛

百度蜘蛛可以算是站长的客人,但是我们遇到过站长问这样一个问题:我们如何判断那些疯狂抓取我们网站内容的蜘蛛是不是百度?其实站长可以通过DNS查IP。判断蜘蛛是否来自百度搜索引擎。根据不同的平台,验证方法不同。例如linux/windows/os三个平台下的验证方式如下:

1、在linux平台下,可以使用host ip命令倒置ip来判断是否是从百度蜘蛛爬取的。百度蜘蛛的主机名以 *. 或 *.baidu.jp,如果不是 *. 或 *.baidu.jp 为冒名顶替。

2、在Windows平台或IBM OS/2平台下,可以使用nslookup ip命令破译ip来判断抓包是否来自Baiduspider。打开命令处理器,输入nslookup xxx.xxx.xxx.xxx(IP地址)解析ip,判断是否是从百度蜘蛛抓到的。百度蜘蛛的主机名以 *. 或 *.baidu.jp,而不是 *. 或者 *.baidu.jp 是冒名顶替。

3、 在mac os平台上,可以使用dig命令破译ip,判断是否是从百度蜘蛛爬取的。打开命令处理器,输入dig xxx.xxx.xxx.xxx(IP地址)解析ip,判断是否来自Baiduspider。百度蜘蛛的主机名以 *. 或 *.baidu.jp,而不是 *. 或者 *.baidu.jp 是冒名顶替。

什么是百度蜘蛛IP

即便很多站长知道怎么判断百度蜘蛛,也会继续问“百度蜘蛛IP是什么”。我们理解站长的意思,就是要把百度蜘蛛的IP加入白名单,只允许白名单下的IP爬网站,避免被采集等动作。

但我们不建议网站管理员这样做。虽然百度蜘蛛确实有一个IP池,并且真实IP是在这个IP池内切换的,但我们不能保证整体IP池不会发生变化。因此,我们建议站长认真阅读日志,在发现恶意蜘蛛后将其加入黑名单,以保证百度的正常爬取。

同时我们再次强调,以IP来区分百度蜘蛛的属性是非常可笑的。所谓的“沙盒蜘蛛”、“委托蜘蛛”等从未存在过。

机器人符号

机器人是网站与蜘蛛进行交流的重要渠道。该站点通过robots文件声明了网站中不想被搜索引擎收录搜索到的部分,或者指定搜索引擎只收录特定的部分。请注意,仅当您的 网站 收录您不想被搜索引擎收录 搜索的内容时,才需要 robots.txt 文件。如果您想要搜索引擎 收录网站 上的所有内容,请不要创建 robots.txt 文件。

robots文件通常放在根目录下,收录一条或多条记录,记录之间用空行分隔(以CR、CR/NL或NL为终止符)。每条记录的格式如下:

“:”

在这个文件中可以使用#作为注解,具体用法同UNIX中的约定。此文件中的记录通常以一行或多行 User-agent 开头,然后是几行 Disallow 和 Allow 行。详细情况如下:

User-agent:此项的值用于描述搜索引擎机器人的名称。在“robots.txt”文件中,如果有多个User-agent记录,则表示多个机器人会受到“robots.txt”的限制。对于此文件,必须至少有一个 User-agent 记录。如果此项的值设置为 *,则对任何机器人都有效。在“robots.txt”文件中,“User-agent:*”只能有一条记录。如果在“robots.txt”文件中,添加“User-agent: SomeBot”和几行Disallow和Allow行,那么“SomeBot”的名称只受“User-agent: SomeBot”后面的Disallow和Allow行的限制。

Disallow:此项的值用于描述一组不想被访问的URL。该值可以是完整路径,也可以是路径的非空前缀。机器人不会访问以 Disallow 项的值开头的 URL。例如,“Disallow:/help”禁止机器人访问/help.html、/helpabc.html、/help/index.html,而“Disallow:/help/”允许机器人访问/help.html、/helpabc。 html,但不能访问 /help/index.html。“Disallow:”表示允许机器人访问网站的所有URL,且“/robots.txt”文件中必须至少有一条Disallow记录。如果“/robots.txt”不存在或为空文件,则 网站 对所有搜索引擎机器人开放。

允许:此项的值用于描述您希望访问的一组 URL。与 Disallow 项类似,该值可以是完整路径,也可以是路径前缀。以 Allow 项的值开头的 URL 是允许机器人访问的。例如“允许:/hibaidu”允许机器人访问/hibaidu.htm、/hibaiducom.html、/hibaidu/com.html。网站 的所有 URL 默认为 Allow,因此 Allow 通常与 Disallow 结合使用,以允许访问某些网页,同时禁止访问所有其他 URL。

使用“*”和“$”:百度蜘蛛支持使用通配符“*”和“$”来模糊匹配url。

"*" 匹配零个或多个任意字符

"$" 匹配行终止符。

最后要注意的是:百度会严格遵守机器人的相关协议。请注意区分您不想被爬取的目录或收录的大小写。与收录的目录完全匹配,否则robots协议不会生效。

机器人要求使用对应表

上面提到的理论有很多。有没有简单的对照表告诉我在什么样的需求场景下怎么写robots文件?是的:

除了机器人之外的其他禁止百度的方式收录

Meta robots标签是页面头部的一种标签,也是用于防止搜索引擎索引页面内容的指令。目前百度只支持nofollow和noarchive

nofollow:阻止搜索引擎跟踪此页面上的链接

如果您不希望搜索引擎跟踪此页面上的链接,并且不传递链接的权重,请将此元标记放置在页面的部分中:

如果不希望百度跟踪特定链接,百度也支持更精准的控制,请直接在链接上写下这个标记:signin

要允许其他搜索引擎关注,但只阻止百度关注您页面的链接,请将此元标记放置在您页面的部分中:

noarchive:阻止搜索引擎在搜索结果中显示网页快照

要防止所有搜索引擎显示您的 网站 快照,请将此元标记放置在您网页的部分中:

要允许其他搜索引擎显示快照,但只阻止百度显示,请使用以下标记:

注意:该标签仅禁止百度显示页面快照。百度将继续对页面进行索引,并在搜索结果中显示页面摘要。

用机器人巧妙避开蜘蛛黑洞

对于百度搜索引擎来说,蜘蛛黑洞特指网站以极低的成本创建大量参数过多、内容相似但不同的url的动态url,就像一个无限循环的“黑洞”,会被困住. Spider 会浪费大量资源来抓取无效网页。

比如很多网站都有过滤功能,过滤功能生成的网页往往被搜索引擎大量抓取,其中很大一部分是检索价值不高的页面。比如“租房价格在500-1000之间”,首先网站(包括现实中)基本没有相关资源,其次,网站用户和搜索用户都没有引擎有这样的检索习惯。这种网页被大量搜索引擎抓取,只能占用网站宝贵的抓取配额,那么如何避免这种情况呢?

下面以北京美团为例,看看美团是如何利用机器人巧妙避开这个蜘蛛黑洞的:

对于普通的过滤结果页面,使用静态链接,如:

同样是条件过滤结果页面。当用户选择不同的排序条件时,会生成不同参数的动态链接,即使使用相同的排序条件(比如都是按销售额降序排序),生成的参数也是不一样的。的。例如:%2Fpoi.0.0.i1afqhek%2Fpoi.0.0.i1afqi5c

对于美团来说,让搜索引擎抓取和过滤结果页面就足够了,而通过robots规则拒绝将各种带参数的结果排序页面提供给搜索引擎。robots.txt的文件使用中有这样一条规则: Disallow: /*?* ,禁止搜索引擎访问网站中的所有动态页面。正是通过这种方式,美团网优先为蜘蛛展示优质页面,屏蔽低质量页面,为蜘蛛提供更友好的网站结构,避免黑洞的形成。

如何禁止百度图片搜索 收录 某些图片

目前,百度图片搜索也使用与百度网页搜索相同的爬虫。如果要禁止百度蜘蛛抓取网站上的所有图片,禁止或允许百度蜘蛛抓取网站上特定格式的图片文件,可以通过设置robots来实现:

禁止百度蜘蛛抓取网站上的所有图片

只允许网页,不允许图像。

用户代理:百度蜘蛛

禁止:/*.jpg$

禁止:/*.jpeg$

禁止:/*.gif$

禁止:/*.png$

禁止:/*.bmp$

只允许百度蜘蛛抓取网页和.gif格式的图片

允许抓取网页和gif格式的图片,不允许抓取其他格式的图片

用户代理:百度蜘蛛

允许:/*.gif$

禁止:/*.jpg$

禁止:/*.jpeg$

禁止:/*.png$

禁止:/*.bmp$

只有百度蜘蛛禁止抓取.jpg格式的图片用户代理:百度蜘蛛

禁止:/*.jpg$

503状态码的使用场景及与404的区别

Html 状态码也是 网站 与蜘蛛通信的渠道之一。它会告诉蜘蛛网页的当前状态,然后蜘蛛会决定下一步该做什么——捕捉还是不捕捉,或者下次检查。200状态码大家已经很熟悉了,下面介绍几种常见的无效网页使用的状态码:

[404] 404 返回码的含义是“未找到”。百度会认为该网页已经失效,所以一般会从搜索结果中删除,短期内蜘蛛不会再次抓取该url。

[503] 503返回码的意思是“服务不可用”,百度会认为网页暂时不可用,通常网站暂时关闭,带宽受限。对于返回503的网页,百度蜘蛛不会直接删除这个url,短期内会再次访问。届时,如果网页已经恢复,则正常爬取;如果继续返回503,短时间内会被多次访问。但如果网页长时间返回503,该url仍会被百度视为无效链接,从搜索结果中删除。

[301] 301返回码的意思是“永久移动”,百度会认为网页当前正在跳转到新的url。遇到网站迁移、域名变更、网站改版等情况,建议使用301返回码,尽量减少改版带来的流量损失。虽然百度蜘蛛现在对 301 跳转的响应时间更长,但还是建议大家这样做。

有的网站把未建的页面放到网上,这些页面被百度爬取的时候,返回码是404,所以这些页面被百度爬取后会作为死链接删除。不过这个页面会在第二天或者几天后建好,会显示在网站中,但是由于之前已经被百度删除为死链接,所以需要等待这些链接被再次发现,然后抓取 这个操作最终会导致一些页面在一段时间内没有出现在百度。例如,某大型门户网站网站爆出大量时效性强但百度不及时收录的新闻话题。经检查核实,发现是因为页面未完成而被放到网上,返回404。

对于这样的问题,建议使用503返回码网站,这样百度的爬虫在收到503返回码后会在一段时间后再次访问这个地址。也可以重新爬取,保证页面及时被爬取和索引,避免不必要的收录和未建内容设置为404后的流量丢失。

其他建议和总结:

1、如果百度蜘蛛对你的网站抓取压力太大,请尽量不要使用404,也建议返回503。这样百度蜘蛛会在一段时间后再次尝试抓取链接. 如果那个时候站点是空闲的,就会爬取成功。

2、如果网站暂时关闭或者页面还没有建好,当网页打不开或者还没有建好时,不要马上返回404,建议使用503状态。503可以通知百度蜘蛛该页面暂时不可用,请稍后再试。

0 连接率的原因和后果及预防措施

当在百度站点遇到“连接率为0”时,说明Baiduspider在访问站点时发现了问题。问题非常严重。如果百度蜘蛛一天无法访问网站,可能会给网站带来灾难性的损失。

一、什么是连通性

由于它是一个比率,它是一个与统计相关的概念。我们不妨理解一个网站的连接率:百度蜘蛛在爬取一个网站页面时计算出来的概率,比如它爬取了某个网站中的N个页面,这个N页面可以被蜘蛛打开并成功爬取,这样的连接率为N/N=100%,反之,蜘蛛抓取N个页面,M个页面可以成功爬取,连接率为M/N

这里先说一些常识:

1、不是网站被算法惩罚,连接率为0,也不是网站流量减少导致连接率很低;

2、连接率代表百度蜘蛛获取网站数据的情况。如果连接率很低或者为0,那么甚至有可能维持网站的正常收录。题;

3、如果网站被判断为未连接,那么如果一个无法连接的站点被允许在百度排名,将极大影响搜索用户的体验,因此百度将采取措施有效引流网站的流量。在清索引操作中,有的站长会发现自己的网站索引量突然急剧下降,甚至短时间内清零为0,随后网站百度搜索流量急剧下降。这突如其来的性事件,会让站长们猜测他们的网站已经被百度处罚了。其实站长首先要注意网站的连通性。

二、提取核心词

在上述概念中,我们需要注意几个词:“百度蜘蛛”;“爬行”;“N 页”;“M 页”;“都可以打开并成功爬取”。

三、连接率很低或为0时

我们抓取上面提取的5个核心词进行分析。

(一)百度蜘蛛

1、谨防百度蜘蛛访问被操纵或禁止

(1)由于百度蜘蛛抓取量等原因,部分服务器承受压力,而这些网络运营商或网站运营商,出于一定利益考虑,有意无意地屏蔽了百度蜘蛛,造成部分服务器或者所有百度蜘蛛ip都无法获取网站数据;

(2)有些网站运营商或网络商对待蜘蛛的方式不同,比如国外蜘蛛ip、山东蜘蛛ip、北京蜘蛛ip等,返回的数据不一样,搬花搬砖的方法层出不穷。树,这个过程非常困难 可能会导致百度蜘蛛的异常行为或异常状态返回;

所以我们首先要确保百度蜘蛛的访问没有被操纵或禁止。

2、注意事项 查看全部

抓取网页数据php(新版移动ua:Mozilla/5.0(Linux;u;+)之前通过“+”进行识别)

新版手机ua:

Mozilla/5.0 (Linux;u;Android 4.2.2;zh-cn;) AppleWebKit/534.46 (KHTML,like Gecko) 版本/5.1 Mobile Safari/10600.6.3(兼容;Baiduspider/2.0;+)

电脑UA:

Mozilla/5.0 (兼容;百度蜘蛛/2.0;+)

请注意 网站 之前用“+”标识!您需要修改识别方法。新识别百度蜘蛛手机ua的正确方法如下:

1. 由关键词“Android”或“Mobile”识别,判断为移动访问或爬取。

2.通过关键词“Baiduspider/2.0”判断为百度爬虫。

还需要强调的是,对于被封禁的机器人,如果被封禁的代理是Baiduspider,它将在PC端和移动端都生效。即无论是PC还是手机百度蜘蛛,都不会抓取被禁对象。之所以要强调这一点,是因为我发现有些代码是适配网站的(同样的url,打开PC ua时是PC页面,打开mobile ua时是手机页面)。以抓取为目的,但是由于PC端和手机端的百度蜘蛛代理都是百度蜘蛛,所以这种方法是非常不可取的。

如何识别百度蜘蛛

百度蜘蛛可以算是站长的客人,但是我们遇到过站长问这样一个问题:我们如何判断那些疯狂抓取我们网站内容的蜘蛛是不是百度?其实站长可以通过DNS查IP。判断蜘蛛是否来自百度搜索引擎。根据不同的平台,验证方法不同。例如linux/windows/os三个平台下的验证方式如下:

1、在linux平台下,可以使用host ip命令倒置ip来判断是否是从百度蜘蛛爬取的。百度蜘蛛的主机名以 *. 或 *.baidu.jp,如果不是 *. 或 *.baidu.jp 为冒名顶替。

2、在Windows平台或IBM OS/2平台下,可以使用nslookup ip命令破译ip来判断抓包是否来自Baiduspider。打开命令处理器,输入nslookup xxx.xxx.xxx.xxx(IP地址)解析ip,判断是否是从百度蜘蛛抓到的。百度蜘蛛的主机名以 *. 或 *.baidu.jp,而不是 *. 或者 *.baidu.jp 是冒名顶替。

3、 在mac os平台上,可以使用dig命令破译ip,判断是否是从百度蜘蛛爬取的。打开命令处理器,输入dig xxx.xxx.xxx.xxx(IP地址)解析ip,判断是否来自Baiduspider。百度蜘蛛的主机名以 *. 或 *.baidu.jp,而不是 *. 或者 *.baidu.jp 是冒名顶替。

什么是百度蜘蛛IP

即便很多站长知道怎么判断百度蜘蛛,也会继续问“百度蜘蛛IP是什么”。我们理解站长的意思,就是要把百度蜘蛛的IP加入白名单,只允许白名单下的IP爬网站,避免被采集等动作。

但我们不建议网站管理员这样做。虽然百度蜘蛛确实有一个IP池,并且真实IP是在这个IP池内切换的,但我们不能保证整体IP池不会发生变化。因此,我们建议站长认真阅读日志,在发现恶意蜘蛛后将其加入黑名单,以保证百度的正常爬取。

同时我们再次强调,以IP来区分百度蜘蛛的属性是非常可笑的。所谓的“沙盒蜘蛛”、“委托蜘蛛”等从未存在过。

机器人符号

机器人是网站与蜘蛛进行交流的重要渠道。该站点通过robots文件声明了网站中不想被搜索引擎收录搜索到的部分,或者指定搜索引擎只收录特定的部分。请注意,仅当您的 网站 收录您不想被搜索引擎收录 搜索的内容时,才需要 robots.txt 文件。如果您想要搜索引擎 收录网站 上的所有内容,请不要创建 robots.txt 文件。

robots文件通常放在根目录下,收录一条或多条记录,记录之间用空行分隔(以CR、CR/NL或NL为终止符)。每条记录的格式如下:

“:”

在这个文件中可以使用#作为注解,具体用法同UNIX中的约定。此文件中的记录通常以一行或多行 User-agent 开头,然后是几行 Disallow 和 Allow 行。详细情况如下:

User-agent:此项的值用于描述搜索引擎机器人的名称。在“robots.txt”文件中,如果有多个User-agent记录,则表示多个机器人会受到“robots.txt”的限制。对于此文件,必须至少有一个 User-agent 记录。如果此项的值设置为 *,则对任何机器人都有效。在“robots.txt”文件中,“User-agent:*”只能有一条记录。如果在“robots.txt”文件中,添加“User-agent: SomeBot”和几行Disallow和Allow行,那么“SomeBot”的名称只受“User-agent: SomeBot”后面的Disallow和Allow行的限制。

Disallow:此项的值用于描述一组不想被访问的URL。该值可以是完整路径,也可以是路径的非空前缀。机器人不会访问以 Disallow 项的值开头的 URL。例如,“Disallow:/help”禁止机器人访问/help.html、/helpabc.html、/help/index.html,而“Disallow:/help/”允许机器人访问/help.html、/helpabc。 html,但不能访问 /help/index.html。“Disallow:”表示允许机器人访问网站的所有URL,且“/robots.txt”文件中必须至少有一条Disallow记录。如果“/robots.txt”不存在或为空文件,则 网站 对所有搜索引擎机器人开放。

允许:此项的值用于描述您希望访问的一组 URL。与 Disallow 项类似,该值可以是完整路径,也可以是路径前缀。以 Allow 项的值开头的 URL 是允许机器人访问的。例如“允许:/hibaidu”允许机器人访问/hibaidu.htm、/hibaiducom.html、/hibaidu/com.html。网站 的所有 URL 默认为 Allow,因此 Allow 通常与 Disallow 结合使用,以允许访问某些网页,同时禁止访问所有其他 URL。

使用“*”和“$”:百度蜘蛛支持使用通配符“*”和“$”来模糊匹配url。

"*" 匹配零个或多个任意字符

"$" 匹配行终止符。

最后要注意的是:百度会严格遵守机器人的相关协议。请注意区分您不想被爬取的目录或收录的大小写。与收录的目录完全匹配,否则robots协议不会生效。

机器人要求使用对应表

上面提到的理论有很多。有没有简单的对照表告诉我在什么样的需求场景下怎么写robots文件?是的:

除了机器人之外的其他禁止百度的方式收录

Meta robots标签是页面头部的一种标签,也是用于防止搜索引擎索引页面内容的指令。目前百度只支持nofollow和noarchive

nofollow:阻止搜索引擎跟踪此页面上的链接

如果您不希望搜索引擎跟踪此页面上的链接,并且不传递链接的权重,请将此元标记放置在页面的部分中:

如果不希望百度跟踪特定链接,百度也支持更精准的控制,请直接在链接上写下这个标记:signin

要允许其他搜索引擎关注,但只阻止百度关注您页面的链接,请将此元标记放置在您页面的部分中:

noarchive:阻止搜索引擎在搜索结果中显示网页快照

要防止所有搜索引擎显示您的 网站 快照,请将此元标记放置在您网页的部分中:

要允许其他搜索引擎显示快照,但只阻止百度显示,请使用以下标记:

注意:该标签仅禁止百度显示页面快照。百度将继续对页面进行索引,并在搜索结果中显示页面摘要。

用机器人巧妙避开蜘蛛黑洞

对于百度搜索引擎来说,蜘蛛黑洞特指网站以极低的成本创建大量参数过多、内容相似但不同的url的动态url,就像一个无限循环的“黑洞”,会被困住. Spider 会浪费大量资源来抓取无效网页。

比如很多网站都有过滤功能,过滤功能生成的网页往往被搜索引擎大量抓取,其中很大一部分是检索价值不高的页面。比如“租房价格在500-1000之间”,首先网站(包括现实中)基本没有相关资源,其次,网站用户和搜索用户都没有引擎有这样的检索习惯。这种网页被大量搜索引擎抓取,只能占用网站宝贵的抓取配额,那么如何避免这种情况呢?

下面以北京美团为例,看看美团是如何利用机器人巧妙避开这个蜘蛛黑洞的:

对于普通的过滤结果页面,使用静态链接,如:

同样是条件过滤结果页面。当用户选择不同的排序条件时,会生成不同参数的动态链接,即使使用相同的排序条件(比如都是按销售额降序排序),生成的参数也是不一样的。的。例如:%2Fpoi.0.0.i1afqhek%2Fpoi.0.0.i1afqi5c

对于美团来说,让搜索引擎抓取和过滤结果页面就足够了,而通过robots规则拒绝将各种带参数的结果排序页面提供给搜索引擎。robots.txt的文件使用中有这样一条规则: Disallow: /*?* ,禁止搜索引擎访问网站中的所有动态页面。正是通过这种方式,美团网优先为蜘蛛展示优质页面,屏蔽低质量页面,为蜘蛛提供更友好的网站结构,避免黑洞的形成。

如何禁止百度图片搜索 收录 某些图片

目前,百度图片搜索也使用与百度网页搜索相同的爬虫。如果要禁止百度蜘蛛抓取网站上的所有图片,禁止或允许百度蜘蛛抓取网站上特定格式的图片文件,可以通过设置robots来实现:

禁止百度蜘蛛抓取网站上的所有图片

只允许网页,不允许图像。

用户代理:百度蜘蛛

禁止:/*.jpg$

禁止:/*.jpeg$

禁止:/*.gif$

禁止:/*.png$

禁止:/*.bmp$

只允许百度蜘蛛抓取网页和.gif格式的图片

允许抓取网页和gif格式的图片,不允许抓取其他格式的图片

用户代理:百度蜘蛛

允许:/*.gif$

禁止:/*.jpg$

禁止:/*.jpeg$

禁止:/*.png$

禁止:/*.bmp$

只有百度蜘蛛禁止抓取.jpg格式的图片用户代理:百度蜘蛛

禁止:/*.jpg$

503状态码的使用场景及与404的区别

Html 状态码也是 网站 与蜘蛛通信的渠道之一。它会告诉蜘蛛网页的当前状态,然后蜘蛛会决定下一步该做什么——捕捉还是不捕捉,或者下次检查。200状态码大家已经很熟悉了,下面介绍几种常见的无效网页使用的状态码:

[404] 404 返回码的含义是“未找到”。百度会认为该网页已经失效,所以一般会从搜索结果中删除,短期内蜘蛛不会再次抓取该url。

[503] 503返回码的意思是“服务不可用”,百度会认为网页暂时不可用,通常网站暂时关闭,带宽受限。对于返回503的网页,百度蜘蛛不会直接删除这个url,短期内会再次访问。届时,如果网页已经恢复,则正常爬取;如果继续返回503,短时间内会被多次访问。但如果网页长时间返回503,该url仍会被百度视为无效链接,从搜索结果中删除。

[301] 301返回码的意思是“永久移动”,百度会认为网页当前正在跳转到新的url。遇到网站迁移、域名变更、网站改版等情况,建议使用301返回码,尽量减少改版带来的流量损失。虽然百度蜘蛛现在对 301 跳转的响应时间更长,但还是建议大家这样做。

有的网站把未建的页面放到网上,这些页面被百度爬取的时候,返回码是404,所以这些页面被百度爬取后会作为死链接删除。不过这个页面会在第二天或者几天后建好,会显示在网站中,但是由于之前已经被百度删除为死链接,所以需要等待这些链接被再次发现,然后抓取 这个操作最终会导致一些页面在一段时间内没有出现在百度。例如,某大型门户网站网站爆出大量时效性强但百度不及时收录的新闻话题。经检查核实,发现是因为页面未完成而被放到网上,返回404。

对于这样的问题,建议使用503返回码网站,这样百度的爬虫在收到503返回码后会在一段时间后再次访问这个地址。也可以重新爬取,保证页面及时被爬取和索引,避免不必要的收录和未建内容设置为404后的流量丢失。

其他建议和总结:

1、如果百度蜘蛛对你的网站抓取压力太大,请尽量不要使用404,也建议返回503。这样百度蜘蛛会在一段时间后再次尝试抓取链接. 如果那个时候站点是空闲的,就会爬取成功。

2、如果网站暂时关闭或者页面还没有建好,当网页打不开或者还没有建好时,不要马上返回404,建议使用503状态。503可以通知百度蜘蛛该页面暂时不可用,请稍后再试。

0 连接率的原因和后果及预防措施

当在百度站点遇到“连接率为0”时,说明Baiduspider在访问站点时发现了问题。问题非常严重。如果百度蜘蛛一天无法访问网站,可能会给网站带来灾难性的损失。

一、什么是连通性

由于它是一个比率,它是一个与统计相关的概念。我们不妨理解一个网站的连接率:百度蜘蛛在爬取一个网站页面时计算出来的概率,比如它爬取了某个网站中的N个页面,这个N页面可以被蜘蛛打开并成功爬取,这样的连接率为N/N=100%,反之,蜘蛛抓取N个页面,M个页面可以成功爬取,连接率为M/N

这里先说一些常识:

1、不是网站被算法惩罚,连接率为0,也不是网站流量减少导致连接率很低;

2、连接率代表百度蜘蛛获取网站数据的情况。如果连接率很低或者为0,那么甚至有可能维持网站的正常收录。题;

3、如果网站被判断为未连接,那么如果一个无法连接的站点被允许在百度排名,将极大影响搜索用户的体验,因此百度将采取措施有效引流网站的流量。在清索引操作中,有的站长会发现自己的网站索引量突然急剧下降,甚至短时间内清零为0,随后网站百度搜索流量急剧下降。这突如其来的性事件,会让站长们猜测他们的网站已经被百度处罚了。其实站长首先要注意网站的连通性。

二、提取核心词

在上述概念中,我们需要注意几个词:“百度蜘蛛”;“爬行”;“N 页”;“M 页”;“都可以打开并成功爬取”。

三、连接率很低或为0时

我们抓取上面提取的5个核心词进行分析。

(一)百度蜘蛛

1、谨防百度蜘蛛访问被操纵或禁止

(1)由于百度蜘蛛抓取量等原因,部分服务器承受压力,而这些网络运营商或网站运营商,出于一定利益考虑,有意无意地屏蔽了百度蜘蛛,造成部分服务器或者所有百度蜘蛛ip都无法获取网站数据;

(2)有些网站运营商或网络商对待蜘蛛的方式不同,比如国外蜘蛛ip、山东蜘蛛ip、北京蜘蛛ip等,返回的数据不一样,搬花搬砖的方法层出不穷。树,这个过程非常困难 可能会导致百度蜘蛛的异常行为或异常状态返回;

所以我们首先要确保百度蜘蛛的访问没有被操纵或禁止。

2、注意事项

抓取网页数据php( 关于网站让引擎蜘蛛快速抓取的方法:网站及页面权重)

网站优化 • 优采云 发表了文章 • 0 个评论 • 75 次浏览 • 2022-04-05 22:13

关于网站让引擎蜘蛛快速抓取的方法:网站及页面权重)

根据真实的调查数据,90%的网民会使用搜索引擎服务寻找自己需要的信息,其中近70%的人会直接在搜索结果自然排名的首页找到自己需要的信息。可见,目前,SEO对于企业和产品有着不可替代的意义。

关于网站让引擎蜘蛛快速爬取的方法:

一、网站 和页面重量。

这绝对是首要的。网站 权重高、资历高、权威高的蜘蛛,绝对是被特殊对待的。这样的网站爬取的频率非常高,大家都知道搜索引擎蜘蛛是为了保证效率,并不是所有页面都会为网站爬取,而且网站的权重越高@>,爬取深度越高,对应的可爬取页面也会增加,这样网站就可以爬取。@收录 也会有更多页面。

二、网站服务器。

网站服务器是网站的基石。如果网站服务器长时间打不开,那谢谢你就离你很近了,蜘蛛也来不了了。百度蜘蛛也是网站的访问者。如果你的服务器不稳定或者比较卡顿,每次爬虫都会很难爬,有时只能爬到页面的一部分。你的体验越来越差,你对网站的分数会越来越低,自然会影响你的网站抢,所以一定要愿意选择空间服务器,有没有好的基础,房子再好。

三、网站 的更新频率。

<p>蜘蛛每次抓取时都会存储页面数据。如果第二次爬取发现页面和第一次 查看全部

抓取网页数据php(

关于网站让引擎蜘蛛快速抓取的方法:网站及页面权重)

根据真实的调查数据,90%的网民会使用搜索引擎服务寻找自己需要的信息,其中近70%的人会直接在搜索结果自然排名的首页找到自己需要的信息。可见,目前,SEO对于企业和产品有着不可替代的意义。

关于网站让引擎蜘蛛快速爬取的方法:

一、网站 和页面重量。

这绝对是首要的。网站 权重高、资历高、权威高的蜘蛛,绝对是被特殊对待的。这样的网站爬取的频率非常高,大家都知道搜索引擎蜘蛛是为了保证效率,并不是所有页面都会为网站爬取,而且网站的权重越高@>,爬取深度越高,对应的可爬取页面也会增加,这样网站就可以爬取。@收录 也会有更多页面。

二、网站服务器。

网站服务器是网站的基石。如果网站服务器长时间打不开,那谢谢你就离你很近了,蜘蛛也来不了了。百度蜘蛛也是网站的访问者。如果你的服务器不稳定或者比较卡顿,每次爬虫都会很难爬,有时只能爬到页面的一部分。你的体验越来越差,你对网站的分数会越来越低,自然会影响你的网站抢,所以一定要愿意选择空间服务器,有没有好的基础,房子再好。

三、网站 的更新频率。

<p>蜘蛛每次抓取时都会存储页面数据。如果第二次爬取发现页面和第一次

抓取网页数据php(PHP脚本不行传输编码(Chunkedtransfer)中的一种机制)

网站优化 • 优采云 发表了文章 • 0 个评论 • 81 次浏览 • 2022-04-04 04:14

今天在做坏事爬别人的页面时遇到了一个问题。通常,在我们发布数据后,要求提交 cookie 是一件大事。但是今天这个测试N次没有cookies,但是爬取总是乱码,为什么?解析不起作用。所以我加了cookies和很多headers,还是一样的问题,开始郁闷了。PHP 脚本不起作用,但同样的提交到浏览器会起作用。这是怎么回事?

于是开始分析我们能看到的数据,终于看到了一个特别的地方。我们平时请求数据的时候,会在header中看到一个php。

Coontent-Length: xxxx

这是本次发送的数据长度,说明是完整的http数据传输,但是今天看到的没有这个项目,而是出现了html。

Transfer-Encoding chunked

于是我开始感到沮丧,这是什么意思。谷歌了一下,终于明白了,找到了解决办法。

维基百科是这样解释的:浏览器

分块传输编码是超文本传输协议 (HTTP) 中的一种数据传输机制,它允许将 Web 服务器发送到客户端应用程序(通常是 Web 浏览器)的 HTTP 数据分成多个部分。分块传输编码仅适用于 HTTP 协议 1.1 版本(HTTP/1.1).

一般情况下,HTTP响应消息中发送的数据是完整发送的,Content-Length消息头域表示数据的长度。数据的长度很重要,因为客户端需要知道回复消息的结束位置和后续回复消息的开始位置。但是,使用分块传输编码,数据被分解成一系列数据块并以一个或多个块的形式发送,这样服务器就可以发送数据,而无需提前知道内容的总大小。通常数据块的大小是一致的,但并非总是如此。服务器

我终于知道这是什么了,数据在那边被分割了。难怪数据总是有问题,于是在网上到处寻找解决办法,终于找到了一个很巧妙的方法:使用HTTP1.0协议,服务器会主动放弃分块编码,所以加一个饼干卷曲

curl_setopt($curl, CURLOPT_HTTP_VERSION, '1.0');

问题解决了,就是这么简单的应用程序 查看全部

抓取网页数据php(PHP脚本不行传输编码(Chunkedtransfer)中的一种机制)

今天在做坏事爬别人的页面时遇到了一个问题。通常,在我们发布数据后,要求提交 cookie 是一件大事。但是今天这个测试N次没有cookies,但是爬取总是乱码,为什么?解析不起作用。所以我加了cookies和很多headers,还是一样的问题,开始郁闷了。PHP 脚本不起作用,但同样的提交到浏览器会起作用。这是怎么回事?

于是开始分析我们能看到的数据,终于看到了一个特别的地方。我们平时请求数据的时候,会在header中看到一个php。

Coontent-Length: xxxx

这是本次发送的数据长度,说明是完整的http数据传输,但是今天看到的没有这个项目,而是出现了html。

Transfer-Encoding chunked

于是我开始感到沮丧,这是什么意思。谷歌了一下,终于明白了,找到了解决办法。

维基百科是这样解释的:浏览器

分块传输编码是超文本传输协议 (HTTP) 中的一种数据传输机制,它允许将 Web 服务器发送到客户端应用程序(通常是 Web 浏览器)的 HTTP 数据分成多个部分。分块传输编码仅适用于 HTTP 协议 1.1 版本(HTTP/1.1).

一般情况下,HTTP响应消息中发送的数据是完整发送的,Content-Length消息头域表示数据的长度。数据的长度很重要,因为客户端需要知道回复消息的结束位置和后续回复消息的开始位置。但是,使用分块传输编码,数据被分解成一系列数据块并以一个或多个块的形式发送,这样服务器就可以发送数据,而无需提前知道内容的总大小。通常数据块的大小是一致的,但并非总是如此。服务器

我终于知道这是什么了,数据在那边被分割了。难怪数据总是有问题,于是在网上到处寻找解决办法,终于找到了一个很巧妙的方法:使用HTTP1.0协议,服务器会主动放弃分块编码,所以加一个饼干卷曲

curl_setopt($curl, CURLOPT_HTTP_VERSION, '1.0');

问题解决了,就是这么简单的应用程序

抓取网页数据phphtml5的php可以通过sqlite数据库来访问

网站优化 • 优采云 发表了文章 • 0 个评论 • 97 次浏览 • 2022-09-03 09:06

抓取网页数据phphtml5的php脚本可以通过sqlite数据库来进行网页数据的访问,当然,这可以进行多个页面数据的同步,并且执行效率很高。除了数据库读写的问题外,这个特性还有一个用途,就是在网页上进行页面视频的读写,并且都保存为文件,比如可以通过php脚本的:来访问并执行相应的操作。

抓取数据抓取任何用户访问过的网页,比如qq浏览器点击一个淘宝的链接,这样,就抓取了qq浏览器的页面地址中的qq这个url,而这个url用于进行php对应的脚本的读写操作。获取cookiecookie机制的存在为php的多页面的缓存加上了一个很重要的步骤,就是获取当前页的cookie地址,这个地址就是浏览器地址的绝对路径,而且在数据库中使用了对应的字段进行存储,如下:然后在下一次数据库查询的时候,从数据库中获取相应的字段,进行查询,从而获取下一页的数据,浏览器的抓取策略是从一个url中读取文件的第一页数据,对应的cookie就存放在一个string类型的url中的response结构体中。

获取单页面爬虫数据有两种获取方式,一种是获取单页面的数据,并且这个数据在整个网页中是唯一的,比如从一个地址找到它的返回页面,这个地址就是返回页面的url,那么需要从这个url中获取相应的数据的时候,就可以使用request.get或者request.post来完成相应的操作。另外一种方式是获取网页的单页面数据,也就是不同的url有不同的返回页面,这种方式是通过返回的数据来识别页面的位置的,也就是经常讲的多跳转。

比如给某人发消息,如果发送到某个微信页面了,那么微信会一直保存这个页面在数据库中。因此,可以通过设置某个字段来指定将第几个url发送到微信并使用在微信对应的地址来请求这个字段。ajax获取ajax实际上是javascript把请求加入到http请求栈的问题,是php的一个特性,javascript在加载完网页之后,在数据库中进行查询操作之前,把一些数据提交给服务器,并要把数据字典转换成为表格字段,然后再传给后面的数据库执行更新。

通过ajax方式,前端可以是发送post请求,服务器端可以是发送get请求。根据ajax方式不同,其执行时间也不同,有兴趣的同学可以关注下。实现拦截拦截的实现过程通常有两种方式,一种是使用循环(pipe),一种是使用生成器(generator)。pipe的使用在javascript中,会发送post请求的请求串,接受请求后,定义response中包含response.readheader为一个固定值的数组。然后,遍历这个数组,遍历到对应的一个就增加一。 查看全部

抓取网页数据phphtml5的php可以通过sqlite数据库来访问

抓取网页数据phphtml5的php脚本可以通过sqlite数据库来进行网页数据的访问,当然,这可以进行多个页面数据的同步,并且执行效率很高。除了数据库读写的问题外,这个特性还有一个用途,就是在网页上进行页面视频的读写,并且都保存为文件,比如可以通过php脚本的:来访问并执行相应的操作。

抓取数据抓取任何用户访问过的网页,比如qq浏览器点击一个淘宝的链接,这样,就抓取了qq浏览器的页面地址中的qq这个url,而这个url用于进行php对应的脚本的读写操作。获取cookiecookie机制的存在为php的多页面的缓存加上了一个很重要的步骤,就是获取当前页的cookie地址,这个地址就是浏览器地址的绝对路径,而且在数据库中使用了对应的字段进行存储,如下:然后在下一次数据库查询的时候,从数据库中获取相应的字段,进行查询,从而获取下一页的数据,浏览器的抓取策略是从一个url中读取文件的第一页数据,对应的cookie就存放在一个string类型的url中的response结构体中。

获取单页面爬虫数据有两种获取方式,一种是获取单页面的数据,并且这个数据在整个网页中是唯一的,比如从一个地址找到它的返回页面,这个地址就是返回页面的url,那么需要从这个url中获取相应的数据的时候,就可以使用request.get或者request.post来完成相应的操作。另外一种方式是获取网页的单页面数据,也就是不同的url有不同的返回页面,这种方式是通过返回的数据来识别页面的位置的,也就是经常讲的多跳转。

比如给某人发消息,如果发送到某个微信页面了,那么微信会一直保存这个页面在数据库中。因此,可以通过设置某个字段来指定将第几个url发送到微信并使用在微信对应的地址来请求这个字段。ajax获取ajax实际上是javascript把请求加入到http请求栈的问题,是php的一个特性,javascript在加载完网页之后,在数据库中进行查询操作之前,把一些数据提交给服务器,并要把数据字典转换成为表格字段,然后再传给后面的数据库执行更新。

通过ajax方式,前端可以是发送post请求,服务器端可以是发送get请求。根据ajax方式不同,其执行时间也不同,有兴趣的同学可以关注下。实现拦截拦截的实现过程通常有两种方式,一种是使用循环(pipe),一种是使用生成器(generator)。pipe的使用在javascript中,会发送post请求的请求串,接受请求后,定义response中包含response.readheader为一个固定值的数组。然后,遍历这个数组,遍历到对应的一个就增加一。

php可以直接读php文件调用phpapi读取数据,比如get、post

网站优化 • 优采云 发表了文章 • 0 个评论 • 91 次浏览 • 2022-08-28 03:09

抓取网页数据php可以直接读php文件edit调用phpapi读取数据,比如get、post如果不需要做数据库连接,那么可以用access_log直接查询sql语句。如果数据量比较大,需要同时读多个文件,还是存到本地吧,目前csdn几乎全部都是本地存储,你需要用到其他的技术把多个文件合并成一个excel如果你主要用于登录验证等功能的开发,那可以用:openidauthentication校验更多php资源,请参考我们的:php极客基地()/。

阿里云ecs套餐,ceph集群,自己买硬件,就可以实现单台电脑的集群,

我不是php的内行,所以这个问题,我也帮不了你,但我想知道,网站服务器的硬件如何做到。一般就是服务器内置硬件的处理能力,1万个,10000-15000元一台。具体硬件处理能力请联系专业人士。

不知道你们还需要多少流量,像阿里云都是1t一年,比如阿里云集群服务器套餐,单台服务器5000元一年,可以去看看,以及php下面的架构有很多,找一个靠谱的,安全稳定的php架构,5~6kw也不是问题,

找家靠谱的厂商处理下重复数据呗

你需要的应该是不一样的处理方式。也是可以做到的。

谢邀,1万台服务器么,估计你需要用开源的es32了吧, 查看全部

php可以直接读php文件调用phpapi读取数据,比如get、post

抓取网页数据php可以直接读php文件edit调用phpapi读取数据,比如get、post如果不需要做数据库连接,那么可以用access_log直接查询sql语句。如果数据量比较大,需要同时读多个文件,还是存到本地吧,目前csdn几乎全部都是本地存储,你需要用到其他的技术把多个文件合并成一个excel如果你主要用于登录验证等功能的开发,那可以用:openidauthentication校验更多php资源,请参考我们的:php极客基地()/。

阿里云ecs套餐,ceph集群,自己买硬件,就可以实现单台电脑的集群,

我不是php的内行,所以这个问题,我也帮不了你,但我想知道,网站服务器的硬件如何做到。一般就是服务器内置硬件的处理能力,1万个,10000-15000元一台。具体硬件处理能力请联系专业人士。

不知道你们还需要多少流量,像阿里云都是1t一年,比如阿里云集群服务器套餐,单台服务器5000元一年,可以去看看,以及php下面的架构有很多,找一个靠谱的,安全稳定的php架构,5~6kw也不是问题,

找家靠谱的厂商处理下重复数据呗

你需要的应该是不一样的处理方式。也是可以做到的。

谢邀,1万台服务器么,估计你需要用开源的es32了吧,

抓取网页数据phpi+还有mysql阿里云有几个日志服务器

网站优化 • 优采云 发表了文章 • 0 个评论 • 82 次浏览 • 2022-08-25 02:03

抓取网页数据phpi++还有mysql阿里云有几个日志服务器,你试试看。这些其实都不是问题的关键是这些应用程序你都是在同一个电脑上完成,和mathematica一样用的是网页浏览器。那些开发环境、编译环境什么的都是小意思了。这些都是开源的,你要学习可以自己找下。我很赞成,要学java,因为php太简单了,而java是世界上最好的语言,没有之一。欢迎交流。

[git]教你怎么从服务器上拉取到你需要的数据。

php自己封装一套框架,本地用sed,

用mysql本地用java自己封装一套系统

把简单的爬虫写起来其实对会php的人就差不多了,这些框架都不用手写,简单的写写爬虫就好了,写io读写就行了,php本身不用像c那样封装任何东西,而是把请求和返回结果抽象成python2中的数据结构(类似于db.dd)。这样你就可以直接用java自己封装的数据结构去完成对接php数据库的需求。

你这样先不考虑是否要学习爬虫,假设你要学php爬虫。买本薄一点的书,把里面基础语法搞清楚,就算你要写demo也就几天的事。剩下就是真正要爬取数据并应用的时候,分库分表、分层、分页等,还有异步请求等。看你想爬哪些网站。以上对php是不是初学者来说都是先不考虑的问题,考虑这些最基础的理论。等你真正开始做,用到的时候就不是难事了。

抓取数据之前你要学会甄别数据、设置目标数据,如果数据是真实的,那么你只要请求和读取就行了,如果数据是pdf什么的可能就需要一点结构化处理和文本处理方面的知识。这些抓取的东西你自己写完可能需要几个星期,可能一天就写完了。另外,你可以有想到可能以后还要用到的的其他的解决方案,先学着把需求优化,看完是否真的适合你,这个决定你后面需要加班加点去实现的东西。如果你也是个初学者,我建议你先解决吃饭问题再考虑下面的问题。 查看全部

抓取网页数据phpi+还有mysql阿里云有几个日志服务器

抓取网页数据phpi++还有mysql阿里云有几个日志服务器,你试试看。这些其实都不是问题的关键是这些应用程序你都是在同一个电脑上完成,和mathematica一样用的是网页浏览器。那些开发环境、编译环境什么的都是小意思了。这些都是开源的,你要学习可以自己找下。我很赞成,要学java,因为php太简单了,而java是世界上最好的语言,没有之一。欢迎交流。

[git]教你怎么从服务器上拉取到你需要的数据。

php自己封装一套框架,本地用sed,

用mysql本地用java自己封装一套系统

把简单的爬虫写起来其实对会php的人就差不多了,这些框架都不用手写,简单的写写爬虫就好了,写io读写就行了,php本身不用像c那样封装任何东西,而是把请求和返回结果抽象成python2中的数据结构(类似于db.dd)。这样你就可以直接用java自己封装的数据结构去完成对接php数据库的需求。

你这样先不考虑是否要学习爬虫,假设你要学php爬虫。买本薄一点的书,把里面基础语法搞清楚,就算你要写demo也就几天的事。剩下就是真正要爬取数据并应用的时候,分库分表、分层、分页等,还有异步请求等。看你想爬哪些网站。以上对php是不是初学者来说都是先不考虑的问题,考虑这些最基础的理论。等你真正开始做,用到的时候就不是难事了。

抓取数据之前你要学会甄别数据、设置目标数据,如果数据是真实的,那么你只要请求和读取就行了,如果数据是pdf什么的可能就需要一点结构化处理和文本处理方面的知识。这些抓取的东西你自己写完可能需要几个星期,可能一天就写完了。另外,你可以有想到可能以后还要用到的的其他的解决方案,先学着把需求优化,看完是否真的适合你,这个决定你后面需要加班加点去实现的东西。如果你也是个初学者,我建议你先解决吃饭问题再考虑下面的问题。

php提供网页提取接口函数websqlphp-sql提供了一个映射关系和传递数据功能

网站优化 • 优采云 发表了文章 • 0 个评论 • 128 次浏览 • 2022-07-02 17:03

抓取网页数据php的开发语言是php提供网页提取接口函数websqlphp-sql提供了一个映射关系和传递数据功能编写代码爬虫爬虫具体的代码这里不详细阐述使用php编写爬虫的工具是laravellaravel是由ryanknapp在2005年编写的,是为web开发打造的一个构建网站的框架。laravel已经成为目前建设、发展和壮大应用最流行的网站开发框架。

laravel最初是作为一个web界面语言设计的,可以使用其构建http、https网站。php语言是根据c计划开发的。php中是不允许动态的,php来构建http和https接口,其中还有许多php代码上的限制,对于php环境本身的支持,一些基本的变量在运行时必须使用php定义,例如整数、字符串、数组、布尔、方法和函数等。

此外,php没有timeline来控制它执行的速度。php传统的文件扩展名是“.php”,和lnmp不同。建议使用“php.2.4以上的版本”。php.2.4以上的版本就在common标签上附加了php_mixed_lib的可执行文件标签,这个文件可以在不同的目录下存在。作为php3.0版本的补充,php_mixed_lib就增加了三个方法。

php_public:静态方法,有它不能直接传递函数参数给定的方法,只能接受参数后传递给调用方的方法php_public:php扩展方法,有它就可以传递函数的参数给某个方法,后面就可以传递给定个方法php_extra:php扩展库的方法,只能传递参数给一个方法php_extra:php扩展库的方法,有它传递参数给某个方法,后面就可以传递给某个方法编写php爬虫时,一定要将页面数据采集下来laravel默认的服务器是vhostfile,如果要加上http代理可以直接使用这个脚本:define_cache_reference("/http",localhost:330。

6);

1、工作流图图中的url作为一个点,是服务器需要访问的请求url,我们可以用prefix这个方法获取页面的唯一标识值和版本,这样对应apache和nginx,获取header也是唯一标识值和版本。

2、组件laravel还有许多组件,包括验证流程单、服务器启动和停止、信息传递、页面载入和返回,这些是交给代理来执行的,因此不用prefix来标识它们,这样也更容易读取。prefix是apache和nginx的标识符,一般这样的作用是域名或ip在本地偏移的二进制序列。

3、关联参数prefix的参数将参数分组为一个个等号(_)的方式:如{"content-type":"text/plain"}这个符号表示你希望使用哪种文本类型,就加上对应的content-type对应的参数,不然所有等号(_)的方式全给你。

4、按照apache和nginx的要求去 查看全部

php提供网页提取接口函数websqlphp-sql提供了一个映射关系和传递数据功能

抓取网页数据php的开发语言是php提供网页提取接口函数websqlphp-sql提供了一个映射关系和传递数据功能编写代码爬虫爬虫具体的代码这里不详细阐述使用php编写爬虫的工具是laravellaravel是由ryanknapp在2005年编写的,是为web开发打造的一个构建网站的框架。laravel已经成为目前建设、发展和壮大应用最流行的网站开发框架。

laravel最初是作为一个web界面语言设计的,可以使用其构建http、https网站。php语言是根据c计划开发的。php中是不允许动态的,php来构建http和https接口,其中还有许多php代码上的限制,对于php环境本身的支持,一些基本的变量在运行时必须使用php定义,例如整数、字符串、数组、布尔、方法和函数等。

此外,php没有timeline来控制它执行的速度。php传统的文件扩展名是“.php”,和lnmp不同。建议使用“php.2.4以上的版本”。php.2.4以上的版本就在common标签上附加了php_mixed_lib的可执行文件标签,这个文件可以在不同的目录下存在。作为php3.0版本的补充,php_mixed_lib就增加了三个方法。

php_public:静态方法,有它不能直接传递函数参数给定的方法,只能接受参数后传递给调用方的方法php_public:php扩展方法,有它就可以传递函数的参数给某个方法,后面就可以传递给定个方法php_extra:php扩展库的方法,只能传递参数给一个方法php_extra:php扩展库的方法,有它传递参数给某个方法,后面就可以传递给某个方法编写php爬虫时,一定要将页面数据采集下来laravel默认的服务器是vhostfile,如果要加上http代理可以直接使用这个脚本:define_cache_reference("/http",localhost:330。

6);

1、工作流图图中的url作为一个点,是服务器需要访问的请求url,我们可以用prefix这个方法获取页面的唯一标识值和版本,这样对应apache和nginx,获取header也是唯一标识值和版本。

2、组件laravel还有许多组件,包括验证流程单、服务器启动和停止、信息传递、页面载入和返回,这些是交给代理来执行的,因此不用prefix来标识它们,这样也更容易读取。prefix是apache和nginx的标识符,一般这样的作用是域名或ip在本地偏移的二进制序列。

3、关联参数prefix的参数将参数分组为一个个等号(_)的方式:如{"content-type":"text/plain"}这个符号表示你希望使用哪种文本类型,就加上对应的content-type对应的参数,不然所有等号(_)的方式全给你。

4、按照apache和nginx的要求去

[精选] 模拟登陆并抓取数据,用php也是可以做到的

网站优化 • 优采云 发表了文章 • 0 个评论 • 50 次浏览 • 2022-06-21 03:31

点击加入:

商务合作请加微信(QQ):2230304070

精选文章正文

服务器活动推荐:【腾讯云12月份服务器限时秒杀活动,最低99元】活动地址:

使用PHP的Curl扩展库可以模拟实现登录,并抓取一些需要用户账号登录以后才能查看的数据。具体实现的流程如下

1. 首先需要对相应的登录页面的html源代码进行分析,获得一些必要的信息:

1)登录页面的地址;

2)验证码的地址;

3)登录表单需要提交的各个字段的名称和提交方式;

4)登录表单提交的地址;

5)另外要需要知道要抓取的数据所在的地址。

2. 获取cookie并存储(针对使用cookie文件的网站)

$login_url = 'http://www.xxxxx'; //登录页面地址<br />$cookie_file = dirname(__FILE__)."/pic.cookie"; //cookie文件存放位置(自定义)<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $login_url);<br />curl_setopt($ch, CURLOPT_HEADER, 0);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER,1);<br />curl_setopt($ch, CURLOPT_COOKIEJAR, $cookie_file);<br />curl_exec($ch);<br />curl_close($ch);<br />

3. 获取验证码并存储(针对使用验证码的网站)

$verify_url = "http://www.xxxx"; //验证码地址<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $verify_url);<br />curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie_file);<br />curl_setopt($ch, CURLOPT_HEADER, 0);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER, 1);<br />$verify_img = curl_exec($ch);<br />curl_close($ch);<br />$fp = fopen("./verify/verifyCode.png",'w'); //把抓取到的图片文件写入本地图片文件保存<br />fwrite($fp, $verify_img);<br />fclose($fp);<br />

说明:

由于不能实现验证码的识别,所以我这里的做法是,把验证码图片抓取下来存放到本地文件中,然后在自己项目中的html页面中显示,让用户去填写,等用户填写完账号、密码和验证码,并点击提交按钮之后再去进行下一步的操作。

4. 模拟提交登录表单:

$ post_url = 'http://www.xxxx'; //登录表单提交地址<br />$post = "username=$account&password=$password&seccodeverify=$verifyCode";//表单提交的数据(根据表单字段名和用户输入决定)<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $ post_url);<br />curl_setopt($ch, CURLOPT_HEADER, false);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER,1);<br />curl_setopt($ch, CURLOPT_POSTFIELDS, $post); //提交方式为post<br />curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie_file);<br />curl_exec($ch);<br />curl_close($ch);<br />

5. 抓取数据:

$data_url = "http://www.xxxx"; //数据所在地址<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $data_url);<br />curl_setopt($ch, CURLOPT_HEADER, false);<br />curl_setopt($ch, CURLOPT_HEADER, 0);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER,0);<br />curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie_file);<br />$data = curl_exec($ch);<br />curl_close($ch);<br />

到目前为止,已经把数据所在地址的这个页面都抓取下来存储在字符串变量$data中了。

需要注意的是抓取下来的是一个网页的html源代码,也就是说这个字符串中不仅包含了你想要的数据,还包含了许多的html标签等你不想要的东西。所以如果你想要从中提取出你需要的数据的话,你还要对存放数据的页面的html代码进行分析,然后结合字符串操作函数、正则匹配等方法从中提取出你想要的数据。 查看全部

[精选] 模拟登陆并抓取数据,用php也是可以做到的

点击加入:

商务合作请加微信(QQ):2230304070

精选文章正文

服务器活动推荐:【腾讯云12月份服务器限时秒杀活动,最低99元】活动地址:

使用PHP的Curl扩展库可以模拟实现登录,并抓取一些需要用户账号登录以后才能查看的数据。具体实现的流程如下

1. 首先需要对相应的登录页面的html源代码进行分析,获得一些必要的信息:

1)登录页面的地址;

2)验证码的地址;

3)登录表单需要提交的各个字段的名称和提交方式;

4)登录表单提交的地址;

5)另外要需要知道要抓取的数据所在的地址。

2. 获取cookie并存储(针对使用cookie文件的网站)

$login_url = 'http://www.xxxxx'; //登录页面地址<br />$cookie_file = dirname(__FILE__)."/pic.cookie"; //cookie文件存放位置(自定义)<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $login_url);<br />curl_setopt($ch, CURLOPT_HEADER, 0);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER,1);<br />curl_setopt($ch, CURLOPT_COOKIEJAR, $cookie_file);<br />curl_exec($ch);<br />curl_close($ch);<br />

3. 获取验证码并存储(针对使用验证码的网站)

$verify_url = "http://www.xxxx"; //验证码地址<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $verify_url);<br />curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie_file);<br />curl_setopt($ch, CURLOPT_HEADER, 0);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER, 1);<br />$verify_img = curl_exec($ch);<br />curl_close($ch);<br />$fp = fopen("./verify/verifyCode.png",'w'); //把抓取到的图片文件写入本地图片文件保存<br />fwrite($fp, $verify_img);<br />fclose($fp);<br />

说明:

由于不能实现验证码的识别,所以我这里的做法是,把验证码图片抓取下来存放到本地文件中,然后在自己项目中的html页面中显示,让用户去填写,等用户填写完账号、密码和验证码,并点击提交按钮之后再去进行下一步的操作。

4. 模拟提交登录表单:

$ post_url = 'http://www.xxxx'; //登录表单提交地址<br />$post = "username=$account&password=$password&seccodeverify=$verifyCode";//表单提交的数据(根据表单字段名和用户输入决定)<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $ post_url);<br />curl_setopt($ch, CURLOPT_HEADER, false);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER,1);<br />curl_setopt($ch, CURLOPT_POSTFIELDS, $post); //提交方式为post<br />curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie_file);<br />curl_exec($ch);<br />curl_close($ch);<br />

5. 抓取数据:

$data_url = "http://www.xxxx"; //数据所在地址<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $data_url);<br />curl_setopt($ch, CURLOPT_HEADER, false);<br />curl_setopt($ch, CURLOPT_HEADER, 0);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER,0);<br />curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie_file);<br />$data = curl_exec($ch);<br />curl_close($ch);<br />

到目前为止,已经把数据所在地址的这个页面都抓取下来存储在字符串变量$data中了。

需要注意的是抓取下来的是一个网页的html源代码,也就是说这个字符串中不仅包含了你想要的数据,还包含了许多的html标签等你不想要的东西。所以如果你想要从中提取出你需要的数据的话,你还要对存放数据的页面的html代码进行分析,然后结合字符串操作函数、正则匹配等方法从中提取出你想要的数据。

web语言基础(vuejs/angularjs)学习经验和教训之谈

网站优化 • 优采云 发表了文章 • 0 个评论 • 106 次浏览 • 2022-06-09 04:04

抓取网页数据php、jsp、asp看到简历数据前端、java看到项目的地址的页面/地址多、复杂、慢

2、读取返回值变量及其使用alibaba。com:返回值,包括两个部分,一个包括alibaba。com的页面信息,一个是职位详情页的内容alibaba。com:status是项目区域和职位详情页的链接,可获取项目区域的数据alibaba。com:item是对应职位详情页的条件查询匹配条件java输入项目的名称“java开发工程师”,返回java开发工程师的简历数据alibaba。

com:返回词库里的数据,获取java开发工程师的职位详情页内容alibaba。com:定义模拟表,返回实际职位的“描述”alibaba。com:返回所有职位的职位信息、公司名、工作地点、薪资。

并不请自来~!先介绍一下我自己情况:第一年从新手到前端老司机,主要是coffeescript+php语言。历经第一年的工作中遇到的坑,也总结了一下学习经验和教训,同时算做自己这一年的回忆。刚好最近公司招聘管理岗,赶上为公司招聘管理岗。想到知乎一直有大神分享博客园博主《做完一个项目就想跳槽》这篇文章,基本过程如下:后端同学:了解coffeescript+php框架前端同学:web语言基础(vuejs/angularjs)前端分析最近经验之谈刚开始接触springcloud,学习dubbo等等一些在之前并没有过接触,需要一定基础:我自己先花了10天完成了一个项目,如下图:这个项目包括入职前,入职中,入职后的日常工作和部分学习的开源代码,自己想学习代码,再开始填坑。并且:。

1、列出了自己这一年踩的坑,共31个。

2、整理出有效的解决方案。

3、学习规划,找时间不管任何东西,一定要养成一个学习习惯,可以和朋友讨论,

4、对比学习框架,花了10天时间找到了合适的框架,自己也逐渐成长,将结果记录下来。

5、最后, 查看全部

web语言基础(vuejs/angularjs)学习经验和教训之谈

抓取网页数据php、jsp、asp看到简历数据前端、java看到项目的地址的页面/地址多、复杂、慢