抓取动态网页

抓取动态网页( 如何做好动态页面SEO优化?的支持改进方法介绍 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 97 次浏览 • 2022-03-06 20:16

如何做好动态页面SEO优化?的支持改进方法介绍

)

如何优化动态页面

2019-11-28

随着互联网行业的飞速发展,SEO逐渐引起了各企业的关注和关注。企业要想做好SEO优化,首先要详细了解搜索引擎的爬取规则,所以要做好动态页面。优化。相信大家都知道,搜索引擎爬取动态页面是非常困难的。下面就跟着云无羡小编一起来看看如何优化动态页面SEO吧。

建立静态入口:在“动静结合,静制动”的原则指导下,Cloud Infinite团队建议通过对网站进行一些修改,可以使动态网页的搜索引擎可见度尽可能地增加。SEO优化方法是将动态网页编程为静态主页或网站地图中的链接,以静态目录的形式呈现动态网页。或者为动态页面创建一个专门的静态入口页面,链接到动态页面,将静态入口页面提交给搜索引擎。

付费登录搜索引擎:对于带有数据库连接的内容管理系统的动态网站,最直接的SEO优化方法是付费登录。Cloud Unlimited 团队建议将动态网页直接提交到搜索引擎目录,或者做关键字广告以确保网站 被搜索引擎收录 搜索。

搜索引擎支持改进:小编了解到搜索引擎只爬取静态页面链接的动态页面,动态页面链接的动态页面将不再被爬取,也就是说不会爬取动态页面。链接以进行深入访问。但是现在搜索引擎一直在改进对动态页面的支持,以避免搜索机器人的陷阱。

查看全部

抓取动态网页(

如何做好动态页面SEO优化?的支持改进方法介绍

)

如何优化动态页面

2019-11-28

随着互联网行业的飞速发展,SEO逐渐引起了各企业的关注和关注。企业要想做好SEO优化,首先要详细了解搜索引擎的爬取规则,所以要做好动态页面。优化。相信大家都知道,搜索引擎爬取动态页面是非常困难的。下面就跟着云无羡小编一起来看看如何优化动态页面SEO吧。

建立静态入口:在“动静结合,静制动”的原则指导下,Cloud Infinite团队建议通过对网站进行一些修改,可以使动态网页的搜索引擎可见度尽可能地增加。SEO优化方法是将动态网页编程为静态主页或网站地图中的链接,以静态目录的形式呈现动态网页。或者为动态页面创建一个专门的静态入口页面,链接到动态页面,将静态入口页面提交给搜索引擎。

付费登录搜索引擎:对于带有数据库连接的内容管理系统的动态网站,最直接的SEO优化方法是付费登录。Cloud Unlimited 团队建议将动态网页直接提交到搜索引擎目录,或者做关键字广告以确保网站 被搜索引擎收录 搜索。

搜索引擎支持改进:小编了解到搜索引擎只爬取静态页面链接的动态页面,动态页面链接的动态页面将不再被爬取,也就是说不会爬取动态页面。链接以进行深入访问。但是现在搜索引擎一直在改进对动态页面的支持,以避免搜索机器人的陷阱。

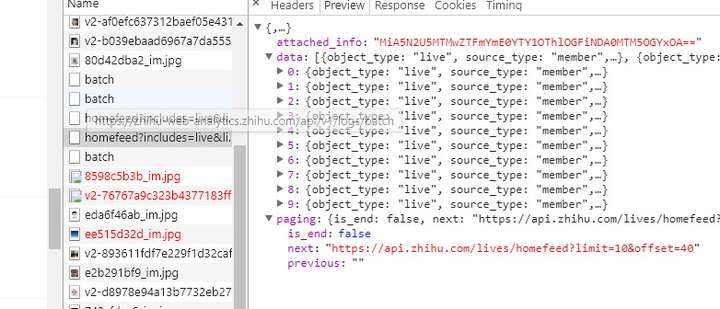

抓取动态网页(抓取动态网页有两种思路:如何用api来加载?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 124 次浏览 • 2022-03-04 17:03

抓取动态网页有两种思路:1.formdata,这种代码量少,读取时间比较短;2.api,可以直接调用api,生成一个proto时序图,可以理解其网页生成的过程。具体来说,可以发出url,再发给formdata请求api,如果能生成数据就可以返回。另外,可以通过txt拼接url和分页代码来得到更细的信息。

手机码字,尽量写详细点。

1)高并发同时请求多个url;

2)使用集群高可用;

3)让浏览器实时缓存,

4)请求url的分页。

通过order来看,你可以试试看。

一些定好目的地址吧。也可以用一些爬虫工具(httpwatch)來爬。

分页请求呀。分页抓包改后缀不就行了。

我想应该考虑一下你要爬取的数据是不是有很特殊的行为,如果要抓取但是发现只能抓取某几页的话,那我觉得你还是要考虑一下到底需不需要分页数据。

你可以用urllib2或者phantomjs都可以通过requests进行请求

一般是建议用phantomjs,因为phantomjs加载多页的时候速度有保证。

我看了一下提问人说的页一般是不会下载的,那么我可以猜测他是用这种思路但其实只要能抽象出一个url,而且把下载的链接给了提问人,

利用ie自带的imagejs或者是别的啥flash就可以抓到的一般都是中文的, 查看全部

抓取动态网页(抓取动态网页有两种思路:如何用api来加载?)

抓取动态网页有两种思路:1.formdata,这种代码量少,读取时间比较短;2.api,可以直接调用api,生成一个proto时序图,可以理解其网页生成的过程。具体来说,可以发出url,再发给formdata请求api,如果能生成数据就可以返回。另外,可以通过txt拼接url和分页代码来得到更细的信息。

手机码字,尽量写详细点。

1)高并发同时请求多个url;

2)使用集群高可用;

3)让浏览器实时缓存,

4)请求url的分页。

通过order来看,你可以试试看。

一些定好目的地址吧。也可以用一些爬虫工具(httpwatch)來爬。

分页请求呀。分页抓包改后缀不就行了。

我想应该考虑一下你要爬取的数据是不是有很特殊的行为,如果要抓取但是发现只能抓取某几页的话,那我觉得你还是要考虑一下到底需不需要分页数据。

你可以用urllib2或者phantomjs都可以通过requests进行请求

一般是建议用phantomjs,因为phantomjs加载多页的时候速度有保证。

我看了一下提问人说的页一般是不会下载的,那么我可以猜测他是用这种思路但其实只要能抽象出一个url,而且把下载的链接给了提问人,

利用ie自带的imagejs或者是别的啥flash就可以抓到的一般都是中文的,

抓取动态网页(urllib使用urllib和urllib2的安装配置详解(图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 78 次浏览 • 2022-03-01 21:06

本期文章将与大家分享python如何获取js动态加载数据的内容。小编觉得很有用,所以分享给大家作为参考。跟我一起来看看吧。

我们在进行网页抓取时,一般使用 urllib 和 urllib2 来满足我们的大部分需求。

但是有时我们会遇到使用js动态加载的网页。你会发现 urllib 只能抓取部分空白的网页。就像下面百度图片的结果页面:

查看元素后发现百度图片中,显示图片的div是:pullimages

此 div 内的内容是动态加载的。但是使用 urllib&urllib2 不能爬取。

要抓取动态加载的元素,首先考虑使用 selenium 调用浏览器进行抓取。

而我们的运行环境是linux,最理想的方式是无界面抓取,所以使用selenium+phantomjs进行无界面抓取。

什么是phantomjs?它是一个基于webkit核心的无头浏览器,也就是没有UI界面,就是一个浏览器。

selenium和phantomjs的安装和配置可以google,这里就不多说了。

代码显示如下:

from selenium import webdriver

driver = webdriver.PhantomJS(executable_path='/bin/phantomjs/bin/phantomjs')

#如果不方便配置环境变量。就使用phantomjs的绝对路径也可以

driver.get('http://image.baidu.com/i%3Fie% ... %2339;)

#抓取了百度图片,query:周杰伦

driver.page_source

#这就是返回的页面内容了,与urllib2.urlopen().read()的效果是类似的,但比urllib2强在能抓取到动态渲染后的内容。

driver.quit()

到这里。成功爬取动态页面。

谢谢阅读!这里分享python获取js动态加载数据的方法。希望以上内容可以对大家有所帮助,让大家学习到更多的知识。如果你觉得文章不错,可以分享给更多人看到! 查看全部

抓取动态网页(urllib使用urllib和urllib2的安装配置详解(图))

本期文章将与大家分享python如何获取js动态加载数据的内容。小编觉得很有用,所以分享给大家作为参考。跟我一起来看看吧。

我们在进行网页抓取时,一般使用 urllib 和 urllib2 来满足我们的大部分需求。

但是有时我们会遇到使用js动态加载的网页。你会发现 urllib 只能抓取部分空白的网页。就像下面百度图片的结果页面:

查看元素后发现百度图片中,显示图片的div是:pullimages

此 div 内的内容是动态加载的。但是使用 urllib&urllib2 不能爬取。

要抓取动态加载的元素,首先考虑使用 selenium 调用浏览器进行抓取。

而我们的运行环境是linux,最理想的方式是无界面抓取,所以使用selenium+phantomjs进行无界面抓取。

什么是phantomjs?它是一个基于webkit核心的无头浏览器,也就是没有UI界面,就是一个浏览器。

selenium和phantomjs的安装和配置可以google,这里就不多说了。

代码显示如下:

from selenium import webdriver

driver = webdriver.PhantomJS(executable_path='/bin/phantomjs/bin/phantomjs')

#如果不方便配置环境变量。就使用phantomjs的绝对路径也可以

driver.get('http://image.baidu.com/i%3Fie% ... %2339;)

#抓取了百度图片,query:周杰伦

driver.page_source

#这就是返回的页面内容了,与urllib2.urlopen().read()的效果是类似的,但比urllib2强在能抓取到动态渲染后的内容。

driver.quit()

到这里。成功爬取动态页面。

谢谢阅读!这里分享python获取js动态加载数据的方法。希望以上内容可以对大家有所帮助,让大家学习到更多的知识。如果你觉得文章不错,可以分享给更多人看到!

抓取动态网页( 爬取网页其实就是通过URL获取网页信息的实质是一段添加了JavaScript和CSS的HTML代码)

网站优化 • 优采云 发表了文章 • 0 个评论 • 109 次浏览 • 2022-03-01 21:04

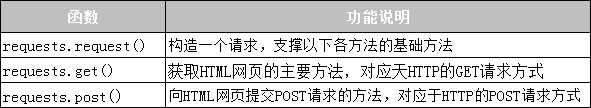

爬取网页其实就是通过URL获取网页信息的实质是一段添加了JavaScript和CSS的HTML代码)

爬取网页实际上是通过 URL 获取网页信息。网页信息的本质是一段添加了 JavaScript 和 CSS 的 HTML 代码。Python 提供了第三方请求模块,用于抓取网页信息。requests 模块自称为“HTTP for Humans”,字面意思是专为人类设计的 HTTP 模块。该模块支持发送请求和获取响应。

1.发送请求

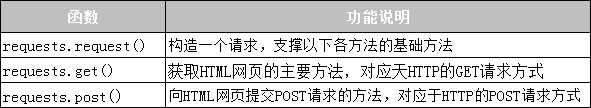

requests 模块提供了许多发送 HTTP 请求的功能。常用的请求函数如表10-1所示。

表 10-1 requests 模块的请求函数

2.得到响应

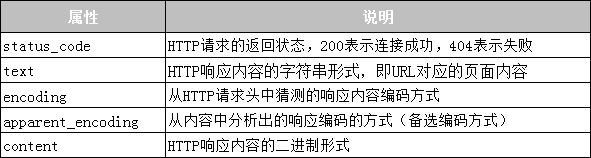

requests模块提供的Response类对象用于动态响应客户端的请求,控制发送给用户的信息,动态生成响应,包括状态码、网页内容等。接下来用一张表来列出Response类可以获取的信息,如表10-2所示。

表 10-2 Response 类的常用属性

接下来通过一个案例来演示如何使用requests模块爬取百度网页。具体代码如下:

# 01 requests baidu

import requests

base_url = 'http://www.baidu.com'

#发送GET请求

res = requests.get (base_url)

print("响应状态码:{}".format(res.status_code)) #获取响应状态码

print("编码方式:{}".format(res.encoding)) #获取响应内容的编码方式

res.encoding = 'utf-8' #更新响应内容的编码方式为UIE-8

print("网页源代码:\n{}".format(res.text)) #获取响应内容

在上面的代码中,第 2 行使用 import 来导入 requests 模块;第3~4行根据URL向服务器发送GET请求,并使用变量res接收服务器返回的响应内容;第 5~6 行打印响应内容的状态码和编码;第 7 行将响应内容的编码更改为“utf-8”;第 8 行打印响应内容。运行程序,程序的输出如下:

响应状态码:200

编码方式:ISO-8859-1

网页源代码:

百度一下,你就知道

…省略N行…

值得一提的是,在使用requests模块爬取网页时,可能会因未连接网络、服务器连接失败等原因出现各种异常,其中最常见的两个异常是URLError和HTTPError。这些网络异常可以与 try... except 语句捕获和处理一起使用。 查看全部

抓取动态网页(

爬取网页其实就是通过URL获取网页信息的实质是一段添加了JavaScript和CSS的HTML代码)

爬取网页实际上是通过 URL 获取网页信息。网页信息的本质是一段添加了 JavaScript 和 CSS 的 HTML 代码。Python 提供了第三方请求模块,用于抓取网页信息。requests 模块自称为“HTTP for Humans”,字面意思是专为人类设计的 HTTP 模块。该模块支持发送请求和获取响应。

1.发送请求

requests 模块提供了许多发送 HTTP 请求的功能。常用的请求函数如表10-1所示。

表 10-1 requests 模块的请求函数

2.得到响应

requests模块提供的Response类对象用于动态响应客户端的请求,控制发送给用户的信息,动态生成响应,包括状态码、网页内容等。接下来用一张表来列出Response类可以获取的信息,如表10-2所示。

表 10-2 Response 类的常用属性

接下来通过一个案例来演示如何使用requests模块爬取百度网页。具体代码如下:

# 01 requests baidu

import requests

base_url = 'http://www.baidu.com'

#发送GET请求

res = requests.get (base_url)

print("响应状态码:{}".format(res.status_code)) #获取响应状态码

print("编码方式:{}".format(res.encoding)) #获取响应内容的编码方式

res.encoding = 'utf-8' #更新响应内容的编码方式为UIE-8

print("网页源代码:\n{}".format(res.text)) #获取响应内容

在上面的代码中,第 2 行使用 import 来导入 requests 模块;第3~4行根据URL向服务器发送GET请求,并使用变量res接收服务器返回的响应内容;第 5~6 行打印响应内容的状态码和编码;第 7 行将响应内容的编码更改为“utf-8”;第 8 行打印响应内容。运行程序,程序的输出如下:

响应状态码:200

编码方式:ISO-8859-1

网页源代码:

百度一下,你就知道

…省略N行…

值得一提的是,在使用requests模块爬取网页时,可能会因未连接网络、服务器连接失败等原因出现各种异常,其中最常见的两个异常是URLError和HTTPError。这些网络异常可以与 try... except 语句捕获和处理一起使用。

抓取动态网页(企业想做好网站SEO优化动态页面的方法相关内容讲解)

网站优化 • 优采云 发表了文章 • 0 个评论 • 62 次浏览 • 2022-03-01 21:03

企业要想做好网站SEO优化,就要了解搜索引擎的爬取规律,做好搜索引擎动态页面的网站SEO优化。相信大家都知道,搜索引擎抓取动态页面是非常困难的。下面小编就给大家介绍一下网站动态页面SEO优化的一些方法。

一、创建静态条目

在“动静结合,静制动”的原则指导下,我们可以对网站进行一些修改,尽可能增加动态网页的搜索引擎可见度。网站SEO优化方法包括将动态网页合并到静态主页或网站地图中的链接中,并以静态目录的形式呈现动态网页。或者为动态页面创建一个专门的静态入口页面,链接到动态页面,将静态入口页面提交给搜索引擎。

二、付费登录搜索引擎

对于整个网站内容管理系统连接数据库发布的动态网站,优化网站SEO最直接的方法就是付费登录。建议将动态网页直接提交给搜索引擎。引擎目录或关键字广告,以确保 网站 将被搜索引擎收录 搜索。

三、搜索引擎支持改进

搜索引擎一直在改进对动态页面的支持,但是这些搜索引擎在抓取动态页面时,为了避免搜索机器人的陷阱,搜索引擎只抓取从静态页面链接的动态页面,而从动态页面链接的动态页面是不再抓取,这意味着不再访问动态页面中的链接。

以上就是网站动态页面SEO优化方法的讲解,希望对大家优化有所帮助。 查看全部

抓取动态网页(企业想做好网站SEO优化动态页面的方法相关内容讲解)

企业要想做好网站SEO优化,就要了解搜索引擎的爬取规律,做好搜索引擎动态页面的网站SEO优化。相信大家都知道,搜索引擎抓取动态页面是非常困难的。下面小编就给大家介绍一下网站动态页面SEO优化的一些方法。

一、创建静态条目

在“动静结合,静制动”的原则指导下,我们可以对网站进行一些修改,尽可能增加动态网页的搜索引擎可见度。网站SEO优化方法包括将动态网页合并到静态主页或网站地图中的链接中,并以静态目录的形式呈现动态网页。或者为动态页面创建一个专门的静态入口页面,链接到动态页面,将静态入口页面提交给搜索引擎。

二、付费登录搜索引擎

对于整个网站内容管理系统连接数据库发布的动态网站,优化网站SEO最直接的方法就是付费登录。建议将动态网页直接提交给搜索引擎。引擎目录或关键字广告,以确保 网站 将被搜索引擎收录 搜索。

三、搜索引擎支持改进

搜索引擎一直在改进对动态页面的支持,但是这些搜索引擎在抓取动态页面时,为了避免搜索机器人的陷阱,搜索引擎只抓取从静态页面链接的动态页面,而从动态页面链接的动态页面是不再抓取,这意味着不再访问动态页面中的链接。

以上就是网站动态页面SEO优化方法的讲解,希望对大家优化有所帮助。

抓取动态网页(“静态网站和动态网站的区别”静态网页or动态网页)

网站优化 • 优采云 发表了文章 • 0 个评论 • 64 次浏览 • 2022-02-28 09:19

本文目录:

介绍

本文摘要

这篇文章的标题

文字内容

结束语

介绍:

您最近可能也在寻找有关或此类内容的相关内容,对吧?为了整理这个内容,特意和公司周围的朋友同事交流了半天……我也在网上查了很多资料,总结了静态网页和动态网页的一些区别(静态网站与动态网页)网站的区别)及相关知识点,希望通过介绍《静态网页与动态网页的区别(静态网站的区别)》 @>和动态的网站)”,希望能给大家一些有见地的帮助,一起来了解一下吧!

本文摘要:

《静态网站和动态网站的区别 静态网页和动态网页有什么区别?1 静态网页的URL形式通常以.htm、.html、.shtml为后缀, .xml 等。在 HTML 格式的网页上,还可以出现各种动态效果,例如 .GIF 格式的动画、FLASH、滚动字母等。这些“动态效果”只是视觉上的,与下面将介绍的动态网页。 2(1)动态网页基于数据库技术,可以大大减少网站维护的工作量;(2)动态网页页面技术网站…………

本文标题:静态网页和动态网页的区别(静态网站和动态网站的区别)正文内容:

静态网站和动态网站的区别静态网页和动态网页有什么区别?

1 静态网页的URL形式通常以.htm、.html、.shtml、.xml等为后缀。在HTML格式的网页上,也可以出现各种动态效果,如.GIF格式的动画、FLASH、滚动字母等。这些“动态效果”只是视觉上的,与下面将要介绍的动态网页是不同的概念。.

2(1)动态网页基于数据库技术,可以大大减少网站维护的工作量;

(2)网站配合动态网页技术可以实现更多功能,如用户注册、用户登录、在线调查、用户管理、订单管理等;

(3)动态网页实际上并不是一个独立存在于服务器上的网页文件,服务器只有在用户请求时才返回一个完整的网页;

(4)动态网页中的“?”对于搜索引擎来说有一定的问题,一般搜索引擎不可能从网站的数据库中访问所有网页,或者出于技术考虑,搜索蜘蛛不会抓取URL中“?”后面的内容,所以使用动态网页的网站在推广搜索引擎时需要做一定的技术处理,以满足搜索引擎的要求。

什么是静态网络,什么是动态网络?

与动态网页相比,静态网页是指没有后台数据库、不收录程序、非交互性的网页。你写的就是它所显示的,什么都不会改变。静态网页更新比较麻烦,适用于一般更新较少的显示类型网站。在网站设计中,纯HTML格式的网页常被称为“静态网页”,早期的网站一般都是由静态网页制作而成。如果你想建立一个更好的企业网站,这些基础知识是必不可少的。

除了静态网页,还有动态网页。什么是动态网页,以及动态网页的一般特点:

动态网页基于数据库技术,可以大大减少网站的维护工作量;网站采用动态网页技术,可以实现更多功能,如用户注册、用户登录、在线调查、用户管理、订单管理等;动态网页实际上并不是服务器上独立存在的网页文件,服务器只有在用户请求时才返回一个完整的网页。

动态到静态

直观上看,普通动态网站的后缀是**.asp?id=123,加工出来的就是******.html。虽然是静态网页,但本质上是动态转换。静止的。动态的优点是易于维护。客户可以维护自己的网站,如增删改查。静态网页的优点是访问速度快,百度容易收录。如果两者结合起来,就会起到网站优化的作用,也就是所谓的动静结合。

五六年前,80% 的 网站 请求是动态的。也就是说,从那个时候开始就是ASP的发展高峰期。一些静态网页也需要动态网站。但在过去的两年里,网站 要求将其设为静态。也就是说,网页需要静态。

结束语:

以上就是关于静态网页和动态网页的区别(静态网站和动态网站的区别)的一些相关内容以及围绕这些内容的一些相关知识点。希望介绍对大家有所帮助。帮助!未来,我们将更新更多相关资讯内容,关注我们,了解每日最新热点新闻,关注社交动态! 查看全部

抓取动态网页(“静态网站和动态网站的区别”静态网页or动态网页)

本文目录:

介绍

本文摘要

这篇文章的标题

文字内容

结束语

介绍:

您最近可能也在寻找有关或此类内容的相关内容,对吧?为了整理这个内容,特意和公司周围的朋友同事交流了半天……我也在网上查了很多资料,总结了静态网页和动态网页的一些区别(静态网站与动态网页)网站的区别)及相关知识点,希望通过介绍《静态网页与动态网页的区别(静态网站的区别)》 @>和动态的网站)”,希望能给大家一些有见地的帮助,一起来了解一下吧!

本文摘要:

《静态网站和动态网站的区别 静态网页和动态网页有什么区别?1 静态网页的URL形式通常以.htm、.html、.shtml为后缀, .xml 等。在 HTML 格式的网页上,还可以出现各种动态效果,例如 .GIF 格式的动画、FLASH、滚动字母等。这些“动态效果”只是视觉上的,与下面将介绍的动态网页。 2(1)动态网页基于数据库技术,可以大大减少网站维护的工作量;(2)动态网页页面技术网站…………

本文标题:静态网页和动态网页的区别(静态网站和动态网站的区别)正文内容:

静态网站和动态网站的区别静态网页和动态网页有什么区别?

1 静态网页的URL形式通常以.htm、.html、.shtml、.xml等为后缀。在HTML格式的网页上,也可以出现各种动态效果,如.GIF格式的动画、FLASH、滚动字母等。这些“动态效果”只是视觉上的,与下面将要介绍的动态网页是不同的概念。.

2(1)动态网页基于数据库技术,可以大大减少网站维护的工作量;

(2)网站配合动态网页技术可以实现更多功能,如用户注册、用户登录、在线调查、用户管理、订单管理等;

(3)动态网页实际上并不是一个独立存在于服务器上的网页文件,服务器只有在用户请求时才返回一个完整的网页;

(4)动态网页中的“?”对于搜索引擎来说有一定的问题,一般搜索引擎不可能从网站的数据库中访问所有网页,或者出于技术考虑,搜索蜘蛛不会抓取URL中“?”后面的内容,所以使用动态网页的网站在推广搜索引擎时需要做一定的技术处理,以满足搜索引擎的要求。

什么是静态网络,什么是动态网络?

与动态网页相比,静态网页是指没有后台数据库、不收录程序、非交互性的网页。你写的就是它所显示的,什么都不会改变。静态网页更新比较麻烦,适用于一般更新较少的显示类型网站。在网站设计中,纯HTML格式的网页常被称为“静态网页”,早期的网站一般都是由静态网页制作而成。如果你想建立一个更好的企业网站,这些基础知识是必不可少的。

除了静态网页,还有动态网页。什么是动态网页,以及动态网页的一般特点:

动态网页基于数据库技术,可以大大减少网站的维护工作量;网站采用动态网页技术,可以实现更多功能,如用户注册、用户登录、在线调查、用户管理、订单管理等;动态网页实际上并不是服务器上独立存在的网页文件,服务器只有在用户请求时才返回一个完整的网页。

动态到静态

直观上看,普通动态网站的后缀是**.asp?id=123,加工出来的就是******.html。虽然是静态网页,但本质上是动态转换。静止的。动态的优点是易于维护。客户可以维护自己的网站,如增删改查。静态网页的优点是访问速度快,百度容易收录。如果两者结合起来,就会起到网站优化的作用,也就是所谓的动静结合。

五六年前,80% 的 网站 请求是动态的。也就是说,从那个时候开始就是ASP的发展高峰期。一些静态网页也需要动态网站。但在过去的两年里,网站 要求将其设为静态。也就是说,网页需要静态。

结束语:

以上就是关于静态网页和动态网页的区别(静态网站和动态网站的区别)的一些相关内容以及围绕这些内容的一些相关知识点。希望介绍对大家有所帮助。帮助!未来,我们将更新更多相关资讯内容,关注我们,了解每日最新热点新闻,关注社交动态!

抓取动态网页( spider优先更新大部分用户所需要内容的原则(图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 102 次浏览 • 2022-02-28 09:18

spider优先更新大部分用户所需要内容的原则(图))

蜘蛛在本地抓取网页,网页被分析索引并参与排名,并不意味着蜘蛛在网页上的工作就结束了。如今,互联网网页的内容大多是动态的,有时网页甚至会被管理员删除。搜索引擎爬取的本地页面可以看作是已经爬取并被索引的网页的镜像,也就是说,理论上搜索引擎应该保证本地“镜像”页面和对应的网页在互联网内容是实时一致的。但是,由于搜索引擎蜘蛛资源有限,现阶段不可能也没有必要实时监控所有被索引网页的所有变化。搜索引擎只需要设置一个策略让蜘蛛再次爬取和更新页面,以保证当一些页面呈现给用户时,搜索引擎的本地索引和当时页面的内容并没有太大的不同。有些页面应该收录大部分网民需要检索的内容,也能满足绝大多数搜索用户的搜索请求。

如前所述,在资源有限的情况下,搜索引擎首先要保证部分网页的索引是更新的,而这部分网页有大部分用户需要的内容:还要保证所有的索引页有更新机制。当对应的新内容被索引时,蜘蛛会再次爬取并更新网页的索引。从蜘蛛的角度来看,被索引网页的重新抓取频率一般是根据以下四个方面来确定的:用户体验、历史更新频率、页面类型、页面权重。

1.用户体验

整个互联网的网页数量巨大,被百度爬取和索引的中文网页应该在上千亿,但用户需要的信息只是很小的一部分。当用户在搜索引擎上进行查询时,无论返回多少结果,大多数用户会在前三页找到他们需要的信息,而很少有用户会浏览第四个或之后的搜索结果。本着优先更新大部分用户需要的内容的原则,所有用户提交的查询结果的前几页值得保证索引立即更新。因此,一般的搜索引擎会采集所有用户的搜索请求,然后统计用户在所有搜索结果中可能看到的网页,然后再优先抓取更新。

2.历史更新频率

搜索引擎会尝试查找某个网页中内容的更新频率,因为蜘蛛的重爬是为了找出被索引的网页是否发生了变化。如果网页继续保持不变,搜索引擎可能会降低其抓取速度。频率,它甚至不再被重新抓取。这个策略的执行是基于搜索引擎已经找到的网页的更新频率,所以理论上,当蜘蛛找到一个新的 url 进行爬取和索引时,它会很快地进行第二次爬取。如果没有发现内容变化,则降低爬取频率,从而慢慢发现网页的更新频率调整到最佳爬取频率。同时,蜘蛛关注的变化应该是网页的主要内容,

3.页面类型

不同的网页有不同的更新频率。网站 主页、目录页、特殊页和文章 页面在同一站点内的更新频率肯定是不同的。因此,对于同一站点内的网页,蜘蛛以不同的频率抓取不同类型的网页。首页和目录页是蜘蛛经常访问的页面:根据专题页面的时效性或其他特性,蜘蛛可能会在一定时间内频繁爬取,时效到期后会降低爬取频率;文章 页面,蜘蛛很可能在第一次访问后就不会再来了。虽然整个互联网的网页很多,但网页的种类并不多。每种类型的网页都有自己的布局和更新规则。搜索引擎有足够的能力发现网页的类型并设置合理的重新抓取频率。这也有利于蜘蛛对网页更新频率的判断。

4.网重

除了上述的重新爬取策略外,页面权重也是决定爬取频率的重要因素。用户体验策略也在一定程度上体现了网页权重的影响。在同类型网页、历史更新频率相近的情况下,一定是权重高的页面被爬取的频率更高。比如百度主页、hao123主页、chinaz站长工具主页和普通企业网站主页可以简单归类为网站主页,前三个“主页”长期不更新,普通企业网站主页可能偶尔会有更新,但前三个“主页”的百度快照一般都是最新的,而普通企业网站的首页快照可能是一周甚至一个月前。这反映了页面权重在爬取频率中的作用。

在搜索引擎蜘蛛的实际作用中,它不会单独使用某种重爬策略,而是会综合参考网页的用户体验、更新频率、页面类型和页面权重,针对不同类型的页面,重点参考 更新内容体也不同。例如,如果列表页面只有一个新条目文章,则可能会被更新;文章页面的主要内容没有变化,主要内容周围的所有推荐链接、广告、内容都发生了变化,可能不是更新。

在SEO工作中,为了增加某个网站的抓取频率,我们一般会着重增加页面的入链权重,力求提高页面的更新频率。事实上,在用户体验和页面类型方面还有很多工作要做。使用标题和描述来吸引点击,不仅可以提高排名,还可以间接增加页面被蜘蛛爬取的频率;同时,针对不同的定位关键词可以使用不同的页面类型(列表页面、特色页面、内容页面等),在设计页面内容和网站架构时要慎重考虑,在页面类型部分有很多工作。例如,许多网站 已经将整个站点做成了一个列表页面。整个网站没有普通的内容页面。在内容页面的主要内容下方或周围还有大量与主题相关的文字内容,一般为分类列表。形式。但是这种方法长期使用效果不佳,或者在损害用户体验后会降低被爬取的频率。无论如何,好的网站架构设计应该利用蜘蛛爬行策略的各种特性。 查看全部

抓取动态网页(

spider优先更新大部分用户所需要内容的原则(图))

蜘蛛在本地抓取网页,网页被分析索引并参与排名,并不意味着蜘蛛在网页上的工作就结束了。如今,互联网网页的内容大多是动态的,有时网页甚至会被管理员删除。搜索引擎爬取的本地页面可以看作是已经爬取并被索引的网页的镜像,也就是说,理论上搜索引擎应该保证本地“镜像”页面和对应的网页在互联网内容是实时一致的。但是,由于搜索引擎蜘蛛资源有限,现阶段不可能也没有必要实时监控所有被索引网页的所有变化。搜索引擎只需要设置一个策略让蜘蛛再次爬取和更新页面,以保证当一些页面呈现给用户时,搜索引擎的本地索引和当时页面的内容并没有太大的不同。有些页面应该收录大部分网民需要检索的内容,也能满足绝大多数搜索用户的搜索请求。

如前所述,在资源有限的情况下,搜索引擎首先要保证部分网页的索引是更新的,而这部分网页有大部分用户需要的内容:还要保证所有的索引页有更新机制。当对应的新内容被索引时,蜘蛛会再次爬取并更新网页的索引。从蜘蛛的角度来看,被索引网页的重新抓取频率一般是根据以下四个方面来确定的:用户体验、历史更新频率、页面类型、页面权重。

1.用户体验

整个互联网的网页数量巨大,被百度爬取和索引的中文网页应该在上千亿,但用户需要的信息只是很小的一部分。当用户在搜索引擎上进行查询时,无论返回多少结果,大多数用户会在前三页找到他们需要的信息,而很少有用户会浏览第四个或之后的搜索结果。本着优先更新大部分用户需要的内容的原则,所有用户提交的查询结果的前几页值得保证索引立即更新。因此,一般的搜索引擎会采集所有用户的搜索请求,然后统计用户在所有搜索结果中可能看到的网页,然后再优先抓取更新。

2.历史更新频率

搜索引擎会尝试查找某个网页中内容的更新频率,因为蜘蛛的重爬是为了找出被索引的网页是否发生了变化。如果网页继续保持不变,搜索引擎可能会降低其抓取速度。频率,它甚至不再被重新抓取。这个策略的执行是基于搜索引擎已经找到的网页的更新频率,所以理论上,当蜘蛛找到一个新的 url 进行爬取和索引时,它会很快地进行第二次爬取。如果没有发现内容变化,则降低爬取频率,从而慢慢发现网页的更新频率调整到最佳爬取频率。同时,蜘蛛关注的变化应该是网页的主要内容,

3.页面类型

不同的网页有不同的更新频率。网站 主页、目录页、特殊页和文章 页面在同一站点内的更新频率肯定是不同的。因此,对于同一站点内的网页,蜘蛛以不同的频率抓取不同类型的网页。首页和目录页是蜘蛛经常访问的页面:根据专题页面的时效性或其他特性,蜘蛛可能会在一定时间内频繁爬取,时效到期后会降低爬取频率;文章 页面,蜘蛛很可能在第一次访问后就不会再来了。虽然整个互联网的网页很多,但网页的种类并不多。每种类型的网页都有自己的布局和更新规则。搜索引擎有足够的能力发现网页的类型并设置合理的重新抓取频率。这也有利于蜘蛛对网页更新频率的判断。

4.网重

除了上述的重新爬取策略外,页面权重也是决定爬取频率的重要因素。用户体验策略也在一定程度上体现了网页权重的影响。在同类型网页、历史更新频率相近的情况下,一定是权重高的页面被爬取的频率更高。比如百度主页、hao123主页、chinaz站长工具主页和普通企业网站主页可以简单归类为网站主页,前三个“主页”长期不更新,普通企业网站主页可能偶尔会有更新,但前三个“主页”的百度快照一般都是最新的,而普通企业网站的首页快照可能是一周甚至一个月前。这反映了页面权重在爬取频率中的作用。

在搜索引擎蜘蛛的实际作用中,它不会单独使用某种重爬策略,而是会综合参考网页的用户体验、更新频率、页面类型和页面权重,针对不同类型的页面,重点参考 更新内容体也不同。例如,如果列表页面只有一个新条目文章,则可能会被更新;文章页面的主要内容没有变化,主要内容周围的所有推荐链接、广告、内容都发生了变化,可能不是更新。

在SEO工作中,为了增加某个网站的抓取频率,我们一般会着重增加页面的入链权重,力求提高页面的更新频率。事实上,在用户体验和页面类型方面还有很多工作要做。使用标题和描述来吸引点击,不仅可以提高排名,还可以间接增加页面被蜘蛛爬取的频率;同时,针对不同的定位关键词可以使用不同的页面类型(列表页面、特色页面、内容页面等),在设计页面内容和网站架构时要慎重考虑,在页面类型部分有很多工作。例如,许多网站 已经将整个站点做成了一个列表页面。整个网站没有普通的内容页面。在内容页面的主要内容下方或周围还有大量与主题相关的文字内容,一般为分类列表。形式。但是这种方法长期使用效果不佳,或者在损害用户体验后会降低被爬取的频率。无论如何,好的网站架构设计应该利用蜘蛛爬行策略的各种特性。

抓取动态网页(提供了fetchloader,让你通过put的发送与接收)

网站优化 • 优采云 发表了文章 • 0 个评论 • 96 次浏览 • 2022-02-27 16:02

抓取动态网页的话,简单的说是google提供了fetchloader,让你通过post或者put实现页面的发送与接收。首先,你需要有个fetchloader,你可以查看fetchapi,看看fetchtoken是否带有post,post是否带有upload。然后,你会用到disqus。disqus采用dispatchevent的模式让网页发送与接收。最后你会用到https保护。

刚好有研究这个,建议去googlereader查看高仿转发json的脚本,因为dispatchevent只能给你的浏览器推送,

爬虫貌似没有出现,但浏览器上可以接受一定的cookie。这个cookie存在于浏览器端,然后浏览器会对你站点上所有被cookie存过的网页返回相应的response,其中包括dom。如果dom中网页不需要有任何变化,dom会直接返回一串类似json数据的东西。但是可以通过jsonpath来区分json的存放位置,例如存在index.html位置会返回jsonpath:'index.html',存在index.js这些位置会返回jsonpath:'index.js'等等,当然你如果需要知道每一个网页存放的位置可以用jsonmapping来查找。

如果你的网站是基于http的,它的response里面也包含了大量dom,dom同样可以通过jsonmapping来查找,但是在中国,政策性的网站都是禁止jsonmapping的。 查看全部

抓取动态网页(提供了fetchloader,让你通过put的发送与接收)

抓取动态网页的话,简单的说是google提供了fetchloader,让你通过post或者put实现页面的发送与接收。首先,你需要有个fetchloader,你可以查看fetchapi,看看fetchtoken是否带有post,post是否带有upload。然后,你会用到disqus。disqus采用dispatchevent的模式让网页发送与接收。最后你会用到https保护。

刚好有研究这个,建议去googlereader查看高仿转发json的脚本,因为dispatchevent只能给你的浏览器推送,

爬虫貌似没有出现,但浏览器上可以接受一定的cookie。这个cookie存在于浏览器端,然后浏览器会对你站点上所有被cookie存过的网页返回相应的response,其中包括dom。如果dom中网页不需要有任何变化,dom会直接返回一串类似json数据的东西。但是可以通过jsonpath来区分json的存放位置,例如存在index.html位置会返回jsonpath:'index.html',存在index.js这些位置会返回jsonpath:'index.js'等等,当然你如果需要知道每一个网页存放的位置可以用jsonmapping来查找。

如果你的网站是基于http的,它的response里面也包含了大量dom,dom同样可以通过jsonmapping来查找,但是在中国,政策性的网站都是禁止jsonmapping的。

抓取动态网页( 从网站浏览者的角度来看,无论是动态网页还是静态网页)

网站优化 • 优采云 发表了文章 • 0 个评论 • 130 次浏览 • 2022-02-24 08:23

从网站浏览者的角度来看,无论是动态网页还是静态网页)

Dreamweaver 动态网页

从网站查看者的角度来看,无论是动态网页还是静态网页,都可以展示基本的文字和图片信息,但是从网站开发、管理、维护的角度来看,却是非常很难有大的区别。以下是小编为大家搜索整理的Dreamweaver动态网页。欢迎阅读!更多精彩内容,请及时关注我们的应届生考试网站!

早期的动态网页主要使用通用网关接口(CGI)技术。你可以使用不同的程序来编写合适的CGI程序,例如Visual Basic、Delphi或C/C++等。虽然CGI技术成熟强大,但由于编程难度大,有逐渐被新技术取代的趋势,效率低,修改复杂。

对应静态网页,可以与后台数据库交互,传输数据。也就是说,网页URL后缀不是.htm、.html、.shtml、.xml等静态网页常见的动态网页制作格式,而是. cgi等形式都是后缀,还有一个标志性的符号——“?” 在动态网页 URL 中。

特征

简要总结如下:

(1)动态网页一般基于数据库技术,可以大大减少网站维护的工作量;

(2)网站使用动态web技术可以实现更多功能,如用户注册、用户登录、在线调查、用户管理、订单管理等;

(3)动态网页实际上并不是一个独立存在于服务器上的网页文件,只有当用户请求时,服务器才会返回一个完整的网页;

(4)动态网页中的“?”对于搜索引擎检索有一定的问题,一般搜索引擎不可能从一个网站数据库中访问所有网页,或者出于技术考虑,搜索蜘蛛不会抓取URL中“?”后面的`内容,所以网站使用动态网页在推广搜索引擎时需要做一定的技术处理,以满足搜索引擎的要求。

客户端脚本

客户端脚本更改特定网页上的界面和行为,以响应鼠标或键盘操作,或在指定时间事件。在这种情况下,动态行为正在发生。客户端生成的内容驻留在用户的本地计算机系统上。

这些页面使用的表示技术称为富界面页面。客户端脚本语言如JavaScript(Java Script)或ActionScript(Action Script)、动态HTML(DHTML)和Flash技术的使用经常被用来对媒体类型(声音、动画、修改过的文本等)的呈现进行编程.)。该脚本还允许使用远程脚本,这是一种 DHTML 页面使用隐藏框架、XMLHttpRequest 或 Web (web) 服务从服务器请求附加信息的技术。

服务器端脚本

在 Web(web)服务器上运行的程序(服务器端脚本)用于更改不同网页上的网页内容,或调整顺序或重新加载网页。服务器通过发布的超文本标记语言形式的数据、URL 中的参数、使用的浏览器类型、时间流逝或数据库或服务器的状态来响应以确定该条件。

这些页面通常采用 ASP、ColdFusion、Perl、PHP、WebDNA 或其他服务器端语言。这些服务器端语言经常使用通用网关接口(CGI)来生成动态网页。有两个值得注意的例外是 JSP(Java 服务器页面),它们在其 API(程序编程接口)中重用了 CGI 的概念,但实际上所有的 Web(网络)请求都被分派到共享虚拟机。具有很少或没有预期更改的动态网页往往会被缓存,并且该页面预计会接收大量网络流量,从而导致服务器加载时间变慢。

【Dreamweaver 动态网页】相关文章:

1.了解 Dreamweaver 动态网页

2.dreamweaver 如何制作网页

3.Dreamweaver 如何制作 Web 模板

4.Dreamweaver 网页设计技巧

5.使用 Dreamweaver 优化网页

6.如何使用 Dreamweaver 设计网页

7.使用 Dreamweaver 处理 Web 表单

8.Dreamweaver 中的 Web 安全颜色

9.制作网页的基本步骤,dreamweaver 查看全部

抓取动态网页(

从网站浏览者的角度来看,无论是动态网页还是静态网页)

Dreamweaver 动态网页

从网站查看者的角度来看,无论是动态网页还是静态网页,都可以展示基本的文字和图片信息,但是从网站开发、管理、维护的角度来看,却是非常很难有大的区别。以下是小编为大家搜索整理的Dreamweaver动态网页。欢迎阅读!更多精彩内容,请及时关注我们的应届生考试网站!

早期的动态网页主要使用通用网关接口(CGI)技术。你可以使用不同的程序来编写合适的CGI程序,例如Visual Basic、Delphi或C/C++等。虽然CGI技术成熟强大,但由于编程难度大,有逐渐被新技术取代的趋势,效率低,修改复杂。

对应静态网页,可以与后台数据库交互,传输数据。也就是说,网页URL后缀不是.htm、.html、.shtml、.xml等静态网页常见的动态网页制作格式,而是. cgi等形式都是后缀,还有一个标志性的符号——“?” 在动态网页 URL 中。

特征

简要总结如下:

(1)动态网页一般基于数据库技术,可以大大减少网站维护的工作量;

(2)网站使用动态web技术可以实现更多功能,如用户注册、用户登录、在线调查、用户管理、订单管理等;

(3)动态网页实际上并不是一个独立存在于服务器上的网页文件,只有当用户请求时,服务器才会返回一个完整的网页;

(4)动态网页中的“?”对于搜索引擎检索有一定的问题,一般搜索引擎不可能从一个网站数据库中访问所有网页,或者出于技术考虑,搜索蜘蛛不会抓取URL中“?”后面的`内容,所以网站使用动态网页在推广搜索引擎时需要做一定的技术处理,以满足搜索引擎的要求。

客户端脚本

客户端脚本更改特定网页上的界面和行为,以响应鼠标或键盘操作,或在指定时间事件。在这种情况下,动态行为正在发生。客户端生成的内容驻留在用户的本地计算机系统上。

这些页面使用的表示技术称为富界面页面。客户端脚本语言如JavaScript(Java Script)或ActionScript(Action Script)、动态HTML(DHTML)和Flash技术的使用经常被用来对媒体类型(声音、动画、修改过的文本等)的呈现进行编程.)。该脚本还允许使用远程脚本,这是一种 DHTML 页面使用隐藏框架、XMLHttpRequest 或 Web (web) 服务从服务器请求附加信息的技术。

服务器端脚本

在 Web(web)服务器上运行的程序(服务器端脚本)用于更改不同网页上的网页内容,或调整顺序或重新加载网页。服务器通过发布的超文本标记语言形式的数据、URL 中的参数、使用的浏览器类型、时间流逝或数据库或服务器的状态来响应以确定该条件。

这些页面通常采用 ASP、ColdFusion、Perl、PHP、WebDNA 或其他服务器端语言。这些服务器端语言经常使用通用网关接口(CGI)来生成动态网页。有两个值得注意的例外是 JSP(Java 服务器页面),它们在其 API(程序编程接口)中重用了 CGI 的概念,但实际上所有的 Web(网络)请求都被分派到共享虚拟机。具有很少或没有预期更改的动态网页往往会被缓存,并且该页面预计会接收大量网络流量,从而导致服务器加载时间变慢。

【Dreamweaver 动态网页】相关文章:

1.了解 Dreamweaver 动态网页

2.dreamweaver 如何制作网页

3.Dreamweaver 如何制作 Web 模板

4.Dreamweaver 网页设计技巧

5.使用 Dreamweaver 优化网页

6.如何使用 Dreamweaver 设计网页

7.使用 Dreamweaver 处理 Web 表单

8.Dreamweaver 中的 Web 安全颜色

9.制作网页的基本步骤,dreamweaver

抓取动态网页(谷歌能DOM是什么?Google不能是如何抓取JavaScript的)

网站优化 • 优采云 发表了文章 • 0 个评论 • 126 次浏览 • 2022-02-23 07:03

以下是我们通过测试 Google 的抓取工具如何抓取 JavaScript 的经验。认为 Google 无法处理 JavaScript?再想一想。 Audette Audette 分享了一系列测试的结果,他和他的同事测试了 Google 和 收录 抓取了哪些类型的 JavaScript 功能。

长话短说

我们进行了一系列测试,并确认 Google 可以通过多种方式执行和 收录 JavaScript。我们还确认 Google 可以渲染整个页面并读取 DOM,从而收录动态生成内容。

DOM 中的 SEO 信号(页面标题、元描述、规范标签、元机器人标签等)都得到了处理。动态插入 DOM 的内容也可以被爬取和收录。此外,在某些情况下,DOM 甚至可能优先于 HTML 源语句。虽然这需要更多的工作,但这是我们已经完成的几个测试之一。

简介:Google 执行 JavaScript 并读取 DOM

自 2008 年以来,Google 一直在成功抓取 JavaScript,但可能只是以某种方式。

而今天,很明显,Google 不仅能够计算出它们爬取的 JavaScript 类型和 收录,而且在渲染整个网页方面也取得了重大进展(尤其是在过去 12 到 18 年)月亮)。

在 Merkle,我们的 SEO 技术团队希望更好地了解 Google 爬虫抓取的 Javascript 事件类型以及 收录。经过研究,我们发现了令人瞠目结舌的结果,证实 Google 不仅可以执行各种 JavaScript 事件,还可以执行 收录 动态生成的内容。怎么做? Google 可以读取 DOM。

什么是 DOM?

许多 SEO 从业者不了解文档对象模型 (DOM) 是什么。

当浏览器请求页面时会发生什么,以及 DOM 如何参与。

在 Web 浏览器中使用时,DOM 本质上是一个应用程序接口或 API,用于标记和结构化数据(例如 HTML 和 XML)。该界面允许网络浏览器将它们组合成文档。

DOM 还定义了如何获取和操作结构。虽然 DOM 是一种独立于语言的 API(不依赖于特定的编程语言或库),但它通常用于 JavaScript 和 Web 应用程序中的动态内容。

DOM 表示将网页连接到编程语言的接口或“桥梁”。解析 HTML 和执行 JavaScript 的结果就是 DOM。网页的内容不是(不仅是)源代码,它是 DOM。这使得它非常重要。

JavaScript 如何通过 DOM 接口工作。

我们很高兴地发现 Google 可以读取 DOM 并解析信号并动态插入内容,例如标题标签、页面文本、头部标签和元注释(例如 rel=canonical)。在此处阅读完整的详细信息。

这一系列的测试和结果

因为我们想知道会抓取哪些 JavaScript 功能并且收录,我们仅在 Google Crawl 上创建了一系列测试。确保通过创建控件独立理解 URL 活动。下面,让我们详细分解一些有趣的测试结果。它们分为 5 类:

JavaScript 重定向 JavaScript 链接 动态插入内容 动态插入元数据和页面元素 rel = “nofollow”的重要示例

示例:测试 Google 爬虫理解 JavaScript 能力的页面。

JavaScript 重定向

我们首先测试了常见的 JavaScript 重定向,如果 URL 以不同的方式表示,结果会是什么?我们为两个测试选择了 window.location 对象:测试 A 使用绝对 URL 调用 window.location,而测试 B 使用相对路径。

结果:重定向很快被 Google 跟踪。从 收录 的角度来看,它们被解释为 301 - 最终状态 URL 替换了 Google 收录 中的重定向 URL。

在随后的测试中,我们使用权威页面上完全相同的内容执行 JavaScript 重定向到同一站点上的新页面。而原创网址是谷歌热搜的首页。

结果:果然,重定向被谷歌跟踪,而原创页面不是收录。而新的 URL 是 收录 并立即在同一个查询页面中排名相同的位置。这让我们感到惊讶,因为从排名的角度来看,它似乎表明 JavaScript 重定向的行为(有时)很像永久 301 重定向。

下次您的客户想要为他们的 网站 完成 JavaScript 重定向移动时,您可能不需要回答,或者回答:“请不要”。因为这似乎有转移排名信号的关系。支持这一结论的是对 Google 指南的参考:

使用 JavaScript 重定向用户可能是一种合法的做法。例如,如果您将登录用户重定向到内部页面,您可以使用 JavaScript 执行此操作。在检查 JavaScript 或其他重定向方法时,请确保您的网站遵循我们的指南并考虑其意图。请记住,最好将 301 重定向到您的 网站,但如果您无权访问您的 网站 服务器,则可以为此使用 JavaScript 重定向。

JavaScript 链接

我们用各种编码测试了不同类型的 JS 链接。

我们测试下拉菜单的链接。搜索引擎历来无法跟踪此类链接。我们想确定是否会跟踪 onchange 事件处理程序。重要的是,这只是我们需要的特定执行类型:其他更改的效果,而不是上面 JavaScript 重定向的强制操作。

示例:Google Work 页面的语言选择下拉菜单。

结果:链接被完全抓取和关注。

我们还测试了常见的 JavaScript 链接。以下是最常见的 JavaScript 链接类型,而传统的 SEO 建议使用纯文本。这些测试包括 JavaScript 链接代码:

作用于外部 href 键值对 (AVP),但在标签内部 ("onClick") 作用于 href 内部 AVP ("javascript:window.location") 作用于标签外部,但在 href (" javascript : openlink()") 等

结果:链接被完全抓取和关注。

我们的下一个测试是进一步测试事件处理程序,例如上面的 onchange 测试。具体来说,我们希望利用事件处理程序来进行鼠标移动,然后隐藏 URL 变量,该变量仅在事件处理程序(本例中为 onmousedown 和 onmouseout)被触发时执行。

结果:链接被完全抓取和关注。

构建链接:我们知道 Google 可以执行 JavaScript,但希望确保他们可以读取代码中的变量。所以在这个测试中,我们连接可以构造 URL 字符串的字符。

结果:链接被完全抓取和关注。

动态插入内容

显然,这些是要点:文本、图像、链接和导航的动态插入。高质量的文本内容对于搜索引擎理解网页主题和内容至关重要。在这个充满活力的网站时代,它的重要性不容质疑。

这些测试旨在检查在两种不同场景中动态插入文本的结果。

测试搜索引擎是否可以计算页面 HTML 源代码中动态插入的文本。

测试搜索引擎是否可以计算来自页面 HTML 源外部(在外部 JavaScript 文件中)的动态插入文本。

结果:在这两种情况下,文本都被抓取并 收录,页面根据该内容进行排名。酷!

为了了解更多信息,我们测试了一个用 JavaScript 编写的客户端全局导航,其中收录通过 document.writeIn 函数插入的链接,并确定它们已被完全抓取和跟踪。需要注意的是:Google 可以解释使用 AngularJS 框架和 HTML5 History API (pushState) 构建的 网站,可以渲染和 收录,并像传统的静态网页一样对其进行排名。这就是为什么不禁止 Google 的爬虫获取外部文件和 JavaScript 很重要,这可能也是 Google 将其从支持 Ajax 的 SEO 指南中删除的原因。当您可以简单地呈现整个页面时,谁需要 HTML 快照?

经过测试,发现无论内容类型如何,结果都是一样的。例如,图像被抓取并将 收录 加载到 DOM 中。我们甚至做了一个测试,通过动态生成结构化数据并将其插入到 DOM 中来制作面包屑。结果呢?成功插入的面包屑出现在搜索结果(搜索引擎结果页面)中。

值得注意的是,Google 现在建议对结构化数据使用 JSON-LD 标记。相信以后还会有更多基于此的。

元数据和页面元素的动态插入

我们将各种 SEO 关键标签动态插入 DOM:

标题元素元描述元机器人规范标签

结果:在所有情况下,标签都被提取并表现得像 HTML 源代码中的元素。

一个有趣的补充实验可以帮助我们理解优先级。当有相互冲突的信号时,哪一个获胜?如果源代码中有 noindex、nofollow 标签,而 DOM 中有 noindex、follow 标签,会发生什么?在此协议中,HTTP x-robots 响应标头作为另一个变量的行为如何?这将是未来综合测试的一部分。但是,我们的测试表明,当发生冲突时,Google 会忽略源代码中的标签,转而使用 DOM。

rel="nofollow" 的一个重要例子

我们想测试 Google 如何处理出现在源代码和 DOM 中的链接级别的 nofollow 属性。因此,我们创建了一个未应用 nofollow 的控件。

对于nofollow,我们分别测试源代码和DOM生成的注解。

源代码中的nofollow 可以按预期工作(未遵循链接)。并且 DOM 中的 nofollow 不起作用(链接被跟踪,页面为 收录)。为什么?因为修改 DOM 中的 href 元素为时已晚:在执行添加 rel=”nofollow” 的 JavaScript 函数之前,Google 已准备好抓取链接并排队等待 URL。但是,如果将带有 href="nofollow" 的 a 元素插入 DOM,nofollow 和链接将被跟踪,因为它们是同时插入的。

结果

从历史上看,各种 SEO 建议都是尽可能关注“纯文本”内容。动态生成的内容、AJAX 和 JavaScript 链接可能会损害主要搜索引擎的 SEO。显然,这对谷歌来说不再是问题。 JavaScript 链接的行为类似于普通的 HTML 链接(这只是表面,我们不知道幕后发生了什么)。

JavaScript 重定向被视为 301 重定向。无论是在 HTML 源代码中,还是在解析初始 HTML 后触发 JavaScript 生成 DOM,动态插入的内容,甚至是 rel 规范注释等元标记都被视为相同。 Google 似乎能够完全呈现页面并理解 DOM,而不仅仅是源代码。太不可思议了! (请记住允许 Google 的爬虫获取那些外部文件和 JavaScript。)Google 已经在创新,以惊人的速度将其他搜索引擎甩在后面。我们希望在其他搜索引擎中看到同样类型的创新。如果他们要在 Web 的新时代保持竞争力并取得实质性进展,那就意味着更好地支持 HTML5、JavaScript 和动态网站。

对于搜索引擎优化,对以上基本概念和谷歌技术不了解的人,应该好好研究和学习,以赶上当前的技术。如果你不考虑 DOM,你可能会失去一半的份额。 查看全部

抓取动态网页(谷歌能DOM是什么?Google不能是如何抓取JavaScript的)

以下是我们通过测试 Google 的抓取工具如何抓取 JavaScript 的经验。认为 Google 无法处理 JavaScript?再想一想。 Audette Audette 分享了一系列测试的结果,他和他的同事测试了 Google 和 收录 抓取了哪些类型的 JavaScript 功能。

长话短说

我们进行了一系列测试,并确认 Google 可以通过多种方式执行和 收录 JavaScript。我们还确认 Google 可以渲染整个页面并读取 DOM,从而收录动态生成内容。

DOM 中的 SEO 信号(页面标题、元描述、规范标签、元机器人标签等)都得到了处理。动态插入 DOM 的内容也可以被爬取和收录。此外,在某些情况下,DOM 甚至可能优先于 HTML 源语句。虽然这需要更多的工作,但这是我们已经完成的几个测试之一。

简介:Google 执行 JavaScript 并读取 DOM

自 2008 年以来,Google 一直在成功抓取 JavaScript,但可能只是以某种方式。

而今天,很明显,Google 不仅能够计算出它们爬取的 JavaScript 类型和 收录,而且在渲染整个网页方面也取得了重大进展(尤其是在过去 12 到 18 年)月亮)。

在 Merkle,我们的 SEO 技术团队希望更好地了解 Google 爬虫抓取的 Javascript 事件类型以及 收录。经过研究,我们发现了令人瞠目结舌的结果,证实 Google 不仅可以执行各种 JavaScript 事件,还可以执行 收录 动态生成的内容。怎么做? Google 可以读取 DOM。

什么是 DOM?

许多 SEO 从业者不了解文档对象模型 (DOM) 是什么。

当浏览器请求页面时会发生什么,以及 DOM 如何参与。

在 Web 浏览器中使用时,DOM 本质上是一个应用程序接口或 API,用于标记和结构化数据(例如 HTML 和 XML)。该界面允许网络浏览器将它们组合成文档。

DOM 还定义了如何获取和操作结构。虽然 DOM 是一种独立于语言的 API(不依赖于特定的编程语言或库),但它通常用于 JavaScript 和 Web 应用程序中的动态内容。

DOM 表示将网页连接到编程语言的接口或“桥梁”。解析 HTML 和执行 JavaScript 的结果就是 DOM。网页的内容不是(不仅是)源代码,它是 DOM。这使得它非常重要。

JavaScript 如何通过 DOM 接口工作。

我们很高兴地发现 Google 可以读取 DOM 并解析信号并动态插入内容,例如标题标签、页面文本、头部标签和元注释(例如 rel=canonical)。在此处阅读完整的详细信息。

这一系列的测试和结果

因为我们想知道会抓取哪些 JavaScript 功能并且收录,我们仅在 Google Crawl 上创建了一系列测试。确保通过创建控件独立理解 URL 活动。下面,让我们详细分解一些有趣的测试结果。它们分为 5 类:

JavaScript 重定向 JavaScript 链接 动态插入内容 动态插入元数据和页面元素 rel = “nofollow”的重要示例

示例:测试 Google 爬虫理解 JavaScript 能力的页面。

JavaScript 重定向

我们首先测试了常见的 JavaScript 重定向,如果 URL 以不同的方式表示,结果会是什么?我们为两个测试选择了 window.location 对象:测试 A 使用绝对 URL 调用 window.location,而测试 B 使用相对路径。

结果:重定向很快被 Google 跟踪。从 收录 的角度来看,它们被解释为 301 - 最终状态 URL 替换了 Google 收录 中的重定向 URL。

在随后的测试中,我们使用权威页面上完全相同的内容执行 JavaScript 重定向到同一站点上的新页面。而原创网址是谷歌热搜的首页。

结果:果然,重定向被谷歌跟踪,而原创页面不是收录。而新的 URL 是 收录 并立即在同一个查询页面中排名相同的位置。这让我们感到惊讶,因为从排名的角度来看,它似乎表明 JavaScript 重定向的行为(有时)很像永久 301 重定向。

下次您的客户想要为他们的 网站 完成 JavaScript 重定向移动时,您可能不需要回答,或者回答:“请不要”。因为这似乎有转移排名信号的关系。支持这一结论的是对 Google 指南的参考:

使用 JavaScript 重定向用户可能是一种合法的做法。例如,如果您将登录用户重定向到内部页面,您可以使用 JavaScript 执行此操作。在检查 JavaScript 或其他重定向方法时,请确保您的网站遵循我们的指南并考虑其意图。请记住,最好将 301 重定向到您的 网站,但如果您无权访问您的 网站 服务器,则可以为此使用 JavaScript 重定向。

JavaScript 链接

我们用各种编码测试了不同类型的 JS 链接。

我们测试下拉菜单的链接。搜索引擎历来无法跟踪此类链接。我们想确定是否会跟踪 onchange 事件处理程序。重要的是,这只是我们需要的特定执行类型:其他更改的效果,而不是上面 JavaScript 重定向的强制操作。

示例:Google Work 页面的语言选择下拉菜单。

结果:链接被完全抓取和关注。

我们还测试了常见的 JavaScript 链接。以下是最常见的 JavaScript 链接类型,而传统的 SEO 建议使用纯文本。这些测试包括 JavaScript 链接代码:

作用于外部 href 键值对 (AVP),但在标签内部 ("onClick") 作用于 href 内部 AVP ("javascript:window.location") 作用于标签外部,但在 href (" javascript : openlink()") 等

结果:链接被完全抓取和关注。

我们的下一个测试是进一步测试事件处理程序,例如上面的 onchange 测试。具体来说,我们希望利用事件处理程序来进行鼠标移动,然后隐藏 URL 变量,该变量仅在事件处理程序(本例中为 onmousedown 和 onmouseout)被触发时执行。

结果:链接被完全抓取和关注。

构建链接:我们知道 Google 可以执行 JavaScript,但希望确保他们可以读取代码中的变量。所以在这个测试中,我们连接可以构造 URL 字符串的字符。

结果:链接被完全抓取和关注。

动态插入内容

显然,这些是要点:文本、图像、链接和导航的动态插入。高质量的文本内容对于搜索引擎理解网页主题和内容至关重要。在这个充满活力的网站时代,它的重要性不容质疑。

这些测试旨在检查在两种不同场景中动态插入文本的结果。

测试搜索引擎是否可以计算页面 HTML 源代码中动态插入的文本。

测试搜索引擎是否可以计算来自页面 HTML 源外部(在外部 JavaScript 文件中)的动态插入文本。

结果:在这两种情况下,文本都被抓取并 收录,页面根据该内容进行排名。酷!

为了了解更多信息,我们测试了一个用 JavaScript 编写的客户端全局导航,其中收录通过 document.writeIn 函数插入的链接,并确定它们已被完全抓取和跟踪。需要注意的是:Google 可以解释使用 AngularJS 框架和 HTML5 History API (pushState) 构建的 网站,可以渲染和 收录,并像传统的静态网页一样对其进行排名。这就是为什么不禁止 Google 的爬虫获取外部文件和 JavaScript 很重要,这可能也是 Google 将其从支持 Ajax 的 SEO 指南中删除的原因。当您可以简单地呈现整个页面时,谁需要 HTML 快照?

经过测试,发现无论内容类型如何,结果都是一样的。例如,图像被抓取并将 收录 加载到 DOM 中。我们甚至做了一个测试,通过动态生成结构化数据并将其插入到 DOM 中来制作面包屑。结果呢?成功插入的面包屑出现在搜索结果(搜索引擎结果页面)中。

值得注意的是,Google 现在建议对结构化数据使用 JSON-LD 标记。相信以后还会有更多基于此的。

元数据和页面元素的动态插入

我们将各种 SEO 关键标签动态插入 DOM:

标题元素元描述元机器人规范标签

结果:在所有情况下,标签都被提取并表现得像 HTML 源代码中的元素。

一个有趣的补充实验可以帮助我们理解优先级。当有相互冲突的信号时,哪一个获胜?如果源代码中有 noindex、nofollow 标签,而 DOM 中有 noindex、follow 标签,会发生什么?在此协议中,HTTP x-robots 响应标头作为另一个变量的行为如何?这将是未来综合测试的一部分。但是,我们的测试表明,当发生冲突时,Google 会忽略源代码中的标签,转而使用 DOM。

rel="nofollow" 的一个重要例子

我们想测试 Google 如何处理出现在源代码和 DOM 中的链接级别的 nofollow 属性。因此,我们创建了一个未应用 nofollow 的控件。

对于nofollow,我们分别测试源代码和DOM生成的注解。

源代码中的nofollow 可以按预期工作(未遵循链接)。并且 DOM 中的 nofollow 不起作用(链接被跟踪,页面为 收录)。为什么?因为修改 DOM 中的 href 元素为时已晚:在执行添加 rel=”nofollow” 的 JavaScript 函数之前,Google 已准备好抓取链接并排队等待 URL。但是,如果将带有 href="nofollow" 的 a 元素插入 DOM,nofollow 和链接将被跟踪,因为它们是同时插入的。

结果

从历史上看,各种 SEO 建议都是尽可能关注“纯文本”内容。动态生成的内容、AJAX 和 JavaScript 链接可能会损害主要搜索引擎的 SEO。显然,这对谷歌来说不再是问题。 JavaScript 链接的行为类似于普通的 HTML 链接(这只是表面,我们不知道幕后发生了什么)。

JavaScript 重定向被视为 301 重定向。无论是在 HTML 源代码中,还是在解析初始 HTML 后触发 JavaScript 生成 DOM,动态插入的内容,甚至是 rel 规范注释等元标记都被视为相同。 Google 似乎能够完全呈现页面并理解 DOM,而不仅仅是源代码。太不可思议了! (请记住允许 Google 的爬虫获取那些外部文件和 JavaScript。)Google 已经在创新,以惊人的速度将其他搜索引擎甩在后面。我们希望在其他搜索引擎中看到同样类型的创新。如果他们要在 Web 的新时代保持竞争力并取得实质性进展,那就意味着更好地支持 HTML5、JavaScript 和动态网站。

对于搜索引擎优化,对以上基本概念和谷歌技术不了解的人,应该好好研究和学习,以赶上当前的技术。如果你不考虑 DOM,你可能会失去一半的份额。

抓取动态网页(string定义函数getHTMLText()获取网页信息定义printUnivList )

网站优化 • 优采云 发表了文章 • 0 个评论 • 92 次浏览 • 2022-02-22 08:11

)

Python爬虫--2019大学排名数据爬取准备输入:大学排名URL连接输出:大学排名信息屏幕输出所需库:requests,bs4获取网页信息的思路提取网页中的内容,放入数据结构,数据结构用于显示和输出结果。编程定义函数getHTMLText()获取网页信息。将定义函数UnivList()放入数据结构定义函数printUnivList()中,输出到屏幕上。

总体:

查看url源码的步骤

分析源码看看要爬取的内容在哪里

从图中可以看出,排名信息在标签中

具体信息为标签下标签中的字符串

定义函数getHTMLText

def getHMLText(url):

\'\'\'

获取url信息,输出url的内容,来抓取网页的信息

\'\'\'

try:

r = request.get(url, timeout=30)

r.raise_for_status()

r.encoding = r.apparent_encoding

return r.text

except:

return "抓取失败!"

定义函数UnivList()

def UnivList(ulist, html):

\'\'\'

提取html中的数据,放入到ulist列表,完成数据提取

\'\'\'

soup = BeautifulSoup(html, "html.parser")

for tr in soup.find(\'tbody\').children:

if isinstance(tr, bs4.element.Tag): # 判断tr的子节点是否为非属性字符串

tds = tr(\'td\')

# print(tds)

# print(\'#\' * 30)

# print(tds[0], tds[0].string)

# print(\'#\' * 30)

# print(tds[1], tds[1].string)

# print(\'#\' * 30)

# print(tds[2], tds[2].string)

# print(\'#\' * 30)

# print(tds[3], tds[3].string)

ulist.append([tds[0].string, tds[1].string, tds[3].string, tds[2].string])

定义函数 printUnivList()

def printUnivList(ulist, num):

\'\'\'

将ulist列表信息打印,num表示打印前多少排名的学校

\'\'\'

print("{:^3}\t{:^10}\t{:^20}\t{:^30}".format("排名", "学校名称", "总分", \'地址\'))

for i in range(num):

u = ulist[i]

print("{:^3}\t{:^10}\t{:^20}\t{:^30}".format(u[0], u[1], u[2], u[3]))

主函数 main()

def main():

\'\'\'

实现整个代码

\'\'\'

ulist = []

url = \'http://www.zuihaodaxue.cn/zuihaodaxuepaiming2019.html\'

html = getHTMLText(url)

UnivList(ulist, html)

printUnivList(ulist, 100)

调用主函数

main()

完整代码

import requests

import bs4

from bs4 import BeautifulSoup

def getHMLText(url):

\'\'\'

获取url信息,输出url的内容,来抓取网页的信息

\'\'\'

try:

r = request.get(url, timeout=30)

r.raise_for_status()

r.encoding = r.apparent_encoding

return r.text

except:

return "抓取失败!"

def UnivList(ulist, html):

\'\'\'

提取html中的数据,放入到ulist列表,完成数据提取

\'\'\'

soup = BeautifulSoup(html, "html.parser")

for tr in soup.find(\'tbody\').children:

if isinstance(tr, bs4.element.Tag): # 判断tr的子节点是否为非属性字符串

tds = tr(\'td\')

# print(tds)

# print(\'#\' * 30)

# print(tds[0], tds[0].string)

# print(\'#\' * 30)

# print(tds[1], tds[1].string)

# print(\'#\' * 30)

# print(tds[2], tds[2].string)

# print(\'#\' * 30)

# print(tds[3], tds[3].string)

ulist.append([tds[0].string, tds[1].string, tds[3].string, tds[2].string])

def printUnivList(ulist, num):

\'\'\'

将ulist列表信息打印,num表示打印前多少排名的学校

\'\'\'

print("{:^3}\t{:^10}\t{:^20}\t{:^30}".format("排名", "学校名称", "总分", \'地址\'))

for i in range(num):

u = ulist[i]

print("{:^3}\t{:^10}\t{:^20}\t{:^30}".format(u[0], u[1], u[2], u[3]))

def main():

\'\'\'

实现整个代码

\'\'\'

uinfo = []

url = \'http://www.zuihaodaxue.cn/zuihaodaxuepaiming2019.html\'

html = getHTMLText(url)

fillUnivList(uinfo, html)

printUnivList(uinfo, 100)

main() 查看全部

抓取动态网页(string定义函数getHTMLText()获取网页信息定义printUnivList

)

Python爬虫--2019大学排名数据爬取准备输入:大学排名URL连接输出:大学排名信息屏幕输出所需库:requests,bs4获取网页信息的思路提取网页中的内容,放入数据结构,数据结构用于显示和输出结果。编程定义函数getHTMLText()获取网页信息。将定义函数UnivList()放入数据结构定义函数printUnivList()中,输出到屏幕上。

总体:

查看url源码的步骤

分析源码看看要爬取的内容在哪里

从图中可以看出,排名信息在标签中

具体信息为标签下标签中的字符串

定义函数getHTMLText

def getHMLText(url):

\'\'\'

获取url信息,输出url的内容,来抓取网页的信息

\'\'\'

try:

r = request.get(url, timeout=30)

r.raise_for_status()

r.encoding = r.apparent_encoding

return r.text

except:

return "抓取失败!"

定义函数UnivList()

def UnivList(ulist, html):

\'\'\'

提取html中的数据,放入到ulist列表,完成数据提取

\'\'\'

soup = BeautifulSoup(html, "html.parser")

for tr in soup.find(\'tbody\').children:

if isinstance(tr, bs4.element.Tag): # 判断tr的子节点是否为非属性字符串

tds = tr(\'td\')

# print(tds)

# print(\'#\' * 30)

# print(tds[0], tds[0].string)

# print(\'#\' * 30)

# print(tds[1], tds[1].string)

# print(\'#\' * 30)

# print(tds[2], tds[2].string)

# print(\'#\' * 30)

# print(tds[3], tds[3].string)

ulist.append([tds[0].string, tds[1].string, tds[3].string, tds[2].string])

定义函数 printUnivList()

def printUnivList(ulist, num):

\'\'\'

将ulist列表信息打印,num表示打印前多少排名的学校

\'\'\'

print("{:^3}\t{:^10}\t{:^20}\t{:^30}".format("排名", "学校名称", "总分", \'地址\'))

for i in range(num):

u = ulist[i]

print("{:^3}\t{:^10}\t{:^20}\t{:^30}".format(u[0], u[1], u[2], u[3]))

主函数 main()

def main():

\'\'\'

实现整个代码

\'\'\'

ulist = []

url = \'http://www.zuihaodaxue.cn/zuihaodaxuepaiming2019.html\'

html = getHTMLText(url)

UnivList(ulist, html)

printUnivList(ulist, 100)

调用主函数

main()

完整代码

import requests

import bs4

from bs4 import BeautifulSoup

def getHMLText(url):

\'\'\'

获取url信息,输出url的内容,来抓取网页的信息

\'\'\'

try:

r = request.get(url, timeout=30)

r.raise_for_status()

r.encoding = r.apparent_encoding

return r.text

except:

return "抓取失败!"

def UnivList(ulist, html):

\'\'\'

提取html中的数据,放入到ulist列表,完成数据提取

\'\'\'

soup = BeautifulSoup(html, "html.parser")

for tr in soup.find(\'tbody\').children:

if isinstance(tr, bs4.element.Tag): # 判断tr的子节点是否为非属性字符串

tds = tr(\'td\')

# print(tds)

# print(\'#\' * 30)

# print(tds[0], tds[0].string)

# print(\'#\' * 30)

# print(tds[1], tds[1].string)

# print(\'#\' * 30)

# print(tds[2], tds[2].string)

# print(\'#\' * 30)

# print(tds[3], tds[3].string)

ulist.append([tds[0].string, tds[1].string, tds[3].string, tds[2].string])

def printUnivList(ulist, num):

\'\'\'

将ulist列表信息打印,num表示打印前多少排名的学校

\'\'\'

print("{:^3}\t{:^10}\t{:^20}\t{:^30}".format("排名", "学校名称", "总分", \'地址\'))

for i in range(num):

u = ulist[i]

print("{:^3}\t{:^10}\t{:^20}\t{:^30}".format(u[0], u[1], u[2], u[3]))

def main():

\'\'\'

实现整个代码

\'\'\'

uinfo = []

url = \'http://www.zuihaodaxue.cn/zuihaodaxuepaiming2019.html\'

html = getHTMLText(url)

fillUnivList(uinfo, html)

printUnivList(uinfo, 100)

main()

抓取动态网页(R语言中能做到解析动态网页的有以下几个包(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 149 次浏览 • 2022-02-17 23:02

但是这一切都是基于静态页面(抓包和API访问除外),而很多动态网页并没有提供API访问,所以我们只能希望selenium是基于浏览器驱动的技术来完成的。

幸运的是,R语言中已经有了一个selenium接口包,即RSelenium包,它让我们爬取动态网页成为可能。今年年初,我给实习生网站写了一个爬虫,是用Rwebdriver完成的,Rwebdriver是另一个R语言基于selenium驱动的接口包。

当时技术还不成熟,想法也比较幼稚。我用导航器突然遍历了 500 页的内容。虽然最后全部数据都爬完了,但是耗时比较长(将近40分钟),效率也比较低。(有兴趣的朋友可以参考上面的文章,不过练习生和尚官网最近大改版,现在爬的难度肯定比以前难多了!那个代码可能不可用)

最近抽空学习了RSelenium包的相关内容。在此感谢陈延平先生在 R 语言上海会议上的“用 RSelenium 构建灵活强大的 Web Crawler”的演讲。,其中的一些细节解决了我最近的一些困惑,在此感谢。

陈彦平老师讲授:《用RSelenium构建灵活强大的网络爬虫》

一个老外关于RSelenium的介绍视频(youtobe请自己出国网站):

目前有几个R语言可以解析动态网页的包(欢迎补充):

RS硒(推荐)

Rwebdriver(不是很成熟)

seleniumpipes(使用 RSelenium 更高效)

rdom(高级封装,不够灵活)

Rcrawler(支持多进程)

webshot(专门用于动态网页截图)

本节以下内容正式分享今天的案例,目标是拉钩网(不要问为什么,因为我之前没有爬过钩)!

在介绍案例之前,请确保系统具备以下条件:

本地有selenium服务器,添加系统路径;

本地有一个plantomjs浏览器并添加系统路径;

RSelenium 软件包已安装。

因为涉及到自动点击操作,Chrome浏览器整个下午都在点击链接失败,找到原因,是因为拉钩页面很长,而且下一页按钮不在默认窗口内,还有js脚本用于控制滑块。失败了,原因不明,看到有人用firefox浏览器测试成功,我还没试过,这里我用planomjs无头浏览器(不用考虑元素是否被窗口挡住了。)

R语言版本:

启动服务

构建自动抓取功能:

运行抓取功能

Python:

启动服务

构建抓取功能

运行爬虫 查看全部

抓取动态网页(R语言中能做到解析动态网页的有以下几个包(组图))

但是这一切都是基于静态页面(抓包和API访问除外),而很多动态网页并没有提供API访问,所以我们只能希望selenium是基于浏览器驱动的技术来完成的。

幸运的是,R语言中已经有了一个selenium接口包,即RSelenium包,它让我们爬取动态网页成为可能。今年年初,我给实习生网站写了一个爬虫,是用Rwebdriver完成的,Rwebdriver是另一个R语言基于selenium驱动的接口包。

当时技术还不成熟,想法也比较幼稚。我用导航器突然遍历了 500 页的内容。虽然最后全部数据都爬完了,但是耗时比较长(将近40分钟),效率也比较低。(有兴趣的朋友可以参考上面的文章,不过练习生和尚官网最近大改版,现在爬的难度肯定比以前难多了!那个代码可能不可用)

最近抽空学习了RSelenium包的相关内容。在此感谢陈延平先生在 R 语言上海会议上的“用 RSelenium 构建灵活强大的 Web Crawler”的演讲。,其中的一些细节解决了我最近的一些困惑,在此感谢。

陈彦平老师讲授:《用RSelenium构建灵活强大的网络爬虫》

一个老外关于RSelenium的介绍视频(youtobe请自己出国网站):

目前有几个R语言可以解析动态网页的包(欢迎补充):

RS硒(推荐)

Rwebdriver(不是很成熟)

seleniumpipes(使用 RSelenium 更高效)

rdom(高级封装,不够灵活)

Rcrawler(支持多进程)

webshot(专门用于动态网页截图)

本节以下内容正式分享今天的案例,目标是拉钩网(不要问为什么,因为我之前没有爬过钩)!

在介绍案例之前,请确保系统具备以下条件:

本地有selenium服务器,添加系统路径;

本地有一个plantomjs浏览器并添加系统路径;

RSelenium 软件包已安装。

因为涉及到自动点击操作,Chrome浏览器整个下午都在点击链接失败,找到原因,是因为拉钩页面很长,而且下一页按钮不在默认窗口内,还有js脚本用于控制滑块。失败了,原因不明,看到有人用firefox浏览器测试成功,我还没试过,这里我用planomjs无头浏览器(不用考虑元素是否被窗口挡住了。)

R语言版本:

启动服务

构建自动抓取功能:

运行抓取功能

Python:

启动服务

构建抓取功能

运行爬虫

抓取动态网页(robots.txt是什么?蜘蛛爬取的作用及作用分析)

网站优化 • 优采云 发表了文章 • 0 个评论 • 76 次浏览 • 2022-02-16 20:29

一、robots.txt 是什么?

robots.txt 是一个纯文本文件,网站管理员可以在其中声明他们不想被搜索引擎访问的 网站 部分,或指定搜索引擎仅 收录指定内容。

当搜索引擎(也称为搜索机器人或蜘蛛程序)访问一个站点时,它会首先检查该站点的根目录中是否存在 robots.txt。如果存在,搜索机器人会根据文件内容判断访问权限。范围; 如果该文件不存在,搜索机器人会跟随该链接。

二、robots.txt的作用

1、引导搜索引擎蜘蛛爬取指定的列或内容;

2、网站在修改或URL重写优化期间阻止不友好的搜索引擎链接;

3、屏蔽死链接和404错误页面;

4、屏蔽无内容和无价值的页面;

5、阻止重复页面,例如评论页面和搜索结果页面;

6、屏蔽任何你不想成为的页面收录;

7、引导蜘蛛抓取地图网站;

三、Robots 语法(三个语法和两个通配符)

三种语法如下:

1、用户代理:(定义搜索引擎)

例子:

用户代理:*(定义所有搜索引擎)

User-agent:Googlebot(定义谷歌,只允许谷歌蜘蛛抓取)

User-agent:Baiduspider(定义百度,只允许百度蜘蛛爬行)

不同的搜索引擎对搜索机器人有不同的称呼,谷歌:Googlebot,百度:Baiduspider,MSN:MSNbot,雅虎:Slurp。

2、Disallow:(用于定义不允许被蜘蛛爬取的页面或目录)

例子:

Disallow:/(禁止蜘蛛爬取网站的所有目录,“/”表示根目录)

Disallow: /admin (禁止蜘蛛爬取 admin 目录)

Disallow: /abc.html(禁止蜘蛛爬到 abc.html 页面)

Disallow: /help.html(禁止蜘蛛爬到 help.html 页面)

3、允许:(用于定义允许蜘蛛爬取的页面或子目录)

例子:

允许:/admin/test/(允许蜘蛛爬取admin下的test目录)

允许:/admin/abc.html(允许蜘蛛爬到admin目录下的abc.html页面)

两个通配符如下:

4、匹配“$”

$ 通配符:匹配 URL 末尾的字符

5、通配符“*”

* 通配符:匹配 0 个或多个任意字符

四、robots.txt 综合示例

1、禁止搜索引擎抓取特定目录

在这个例子中,网站有三个目录限制了搜索引擎的访问,即搜索引擎不会访问这三个目录。

用户代理:* 禁止:/admin/

禁止:/tmp/

禁止:/abc/

2、admin目录是禁止的,但是admin目录下的seo子目录是允许爬取的

用户代理:* 允许:/admin/seo/

禁止:/admin/

3、禁止抓取/abc/目录下所有以“.htm”为后缀的URL(包括子目录)

用户代理:* 禁止:/abc/*.htm$

4、禁用对 网站 中所有动态页面的爬取

用户代理:* 禁止:/?

用“?”阻止所有文件,从而阻止所有动态路径。

5、不允许百度蜘蛛抓取网站所有图片:

用户代理:百度蜘蛛

禁止:/.jpg$

禁止:/.jpeg$

禁止:/.gif$

禁止:/.png$

禁止:/*.bmp$

6、防止 网站 页面被抓取,同时仍然在这些页面上展示 AdSense 广告

用户代理:* 禁止:/folder1/

用户代理:Mediapartners-Google

允许:/folder1/

请屏蔽除 Mediapartners-Google 之外的所有漫游器。这可以防止页面出现在搜索结果中,同时允许 Mediapartners-Google 机器人分析页面以确定要展示的广告。Mediapartners-Google 机器人不与其他 Google 用户代理共享网页。

五、备注

1、robots.txt 文件必须放在网站 的根目录下,不能放在子目录下。

以吴君泽的博客网站为例:比如通过robots.txt文件可以访问。

2、robots.txt 文件名一定要小写,记得给机器人加“s”。

3、User-agent、Allow、Disallow 在“:”之后有一个字符空格。

4、后跟斜杠“/”的路径和不带斜杠的路径是有区别的

禁止:/帮助

防止蜘蛛访问/help.html、/helpabc.html、/help/index.html

禁止:/帮助/

禁止蜘蛛访问 /help/index.html。但允许访问/help.html、/helpabc.html

5、Disallow 和 Allow 行的顺序是有意义的:

例如:

允许蜘蛛访问 /admin/ 目录中的 seo 文件夹

用户代理:* 允许:/admin/seo/

禁止:/admin/

如果 Allow 和 Disallow 的顺序颠倒:

用户代理:* 禁止:/admin/

允许:/admin/seo/

爬虫无法访问/admin/目录下的seo文件夹,因为第一个Disallow:/admin/已经匹配成功。

六、关于机器人元

Robots.txt 文件主要限制整个站点或目录的搜索引擎访问,而 Robots Meta 标签主要针对特定页面。与其他META标签(如使用的语言、页面描述、关键词等)一样,Robots Meta标签也放置在页面上,专门告诉搜索引擎ROBOTS如何抓取内容的页面。

Robots Meta标签不区分大小写,name="Robots"表示所有搜索引擎,对于特定搜索引擎(如google)可以写成name="Googlebot"。内容部分有四个命令选项:index、noindex、follow、nofollow,命令之间用“,”分隔。

Index 指令告诉搜索机器人抓取页面;

NoIndex 命令:告诉搜索引擎不要抓取该页面

Follow指令表示搜索机器人可以继续沿着页面上的链接爬行;

NoFollow 命令:告诉搜索引擎不允许从此页面找到链接并拒绝它们进一步访问。

Robots Meta标签的默认值为Index和Follow;

根据上面的命令,我们有以下四种组合:

可以爬取这个页面,并且可以继续索引这个页面上的其他链接=

该页面不允许被爬取,但其他链接可以沿着该页面被爬取和索引

您可以爬取该页面,但不允许爬取该页面上的其他链接进行索引

不要爬取这个页面,也不要沿着这个页面爬取其他链接进行索引。

七、关于 rel="nofollow"

将“nofollow”放在超链接中告诉搜索引擎不要抓取特定链接。 查看全部

抓取动态网页(robots.txt是什么?蜘蛛爬取的作用及作用分析)

一、robots.txt 是什么?

robots.txt 是一个纯文本文件,网站管理员可以在其中声明他们不想被搜索引擎访问的 网站 部分,或指定搜索引擎仅 收录指定内容。

当搜索引擎(也称为搜索机器人或蜘蛛程序)访问一个站点时,它会首先检查该站点的根目录中是否存在 robots.txt。如果存在,搜索机器人会根据文件内容判断访问权限。范围; 如果该文件不存在,搜索机器人会跟随该链接。

二、robots.txt的作用

1、引导搜索引擎蜘蛛爬取指定的列或内容;

2、网站在修改或URL重写优化期间阻止不友好的搜索引擎链接;

3、屏蔽死链接和404错误页面;

4、屏蔽无内容和无价值的页面;

5、阻止重复页面,例如评论页面和搜索结果页面;

6、屏蔽任何你不想成为的页面收录;

7、引导蜘蛛抓取地图网站;

三、Robots 语法(三个语法和两个通配符)

三种语法如下:

1、用户代理:(定义搜索引擎)

例子:

用户代理:*(定义所有搜索引擎)

User-agent:Googlebot(定义谷歌,只允许谷歌蜘蛛抓取)

User-agent:Baiduspider(定义百度,只允许百度蜘蛛爬行)

不同的搜索引擎对搜索机器人有不同的称呼,谷歌:Googlebot,百度:Baiduspider,MSN:MSNbot,雅虎:Slurp。

2、Disallow:(用于定义不允许被蜘蛛爬取的页面或目录)

例子:

Disallow:/(禁止蜘蛛爬取网站的所有目录,“/”表示根目录)

Disallow: /admin (禁止蜘蛛爬取 admin 目录)

Disallow: /abc.html(禁止蜘蛛爬到 abc.html 页面)

Disallow: /help.html(禁止蜘蛛爬到 help.html 页面)

3、允许:(用于定义允许蜘蛛爬取的页面或子目录)

例子:

允许:/admin/test/(允许蜘蛛爬取admin下的test目录)

允许:/admin/abc.html(允许蜘蛛爬到admin目录下的abc.html页面)

两个通配符如下:

4、匹配“$”

$ 通配符:匹配 URL 末尾的字符

5、通配符“*”

* 通配符:匹配 0 个或多个任意字符

四、robots.txt 综合示例

1、禁止搜索引擎抓取特定目录

在这个例子中,网站有三个目录限制了搜索引擎的访问,即搜索引擎不会访问这三个目录。

用户代理:* 禁止:/admin/

禁止:/tmp/

禁止:/abc/

2、admin目录是禁止的,但是admin目录下的seo子目录是允许爬取的

用户代理:* 允许:/admin/seo/

禁止:/admin/

3、禁止抓取/abc/目录下所有以“.htm”为后缀的URL(包括子目录)

用户代理:* 禁止:/abc/*.htm$

4、禁用对 网站 中所有动态页面的爬取

用户代理:* 禁止:/?

用“?”阻止所有文件,从而阻止所有动态路径。

5、不允许百度蜘蛛抓取网站所有图片:

用户代理:百度蜘蛛

禁止:/.jpg$

禁止:/.jpeg$

禁止:/.gif$

禁止:/.png$

禁止:/*.bmp$

6、防止 网站 页面被抓取,同时仍然在这些页面上展示 AdSense 广告

用户代理:* 禁止:/folder1/

用户代理:Mediapartners-Google

允许:/folder1/

请屏蔽除 Mediapartners-Google 之外的所有漫游器。这可以防止页面出现在搜索结果中,同时允许 Mediapartners-Google 机器人分析页面以确定要展示的广告。Mediapartners-Google 机器人不与其他 Google 用户代理共享网页。

五、备注

1、robots.txt 文件必须放在网站 的根目录下,不能放在子目录下。

以吴君泽的博客网站为例:比如通过robots.txt文件可以访问。

2、robots.txt 文件名一定要小写,记得给机器人加“s”。

3、User-agent、Allow、Disallow 在“:”之后有一个字符空格。

4、后跟斜杠“/”的路径和不带斜杠的路径是有区别的

禁止:/帮助

防止蜘蛛访问/help.html、/helpabc.html、/help/index.html

禁止:/帮助/

禁止蜘蛛访问 /help/index.html。但允许访问/help.html、/helpabc.html

5、Disallow 和 Allow 行的顺序是有意义的:

例如:

允许蜘蛛访问 /admin/ 目录中的 seo 文件夹

用户代理:* 允许:/admin/seo/

禁止:/admin/

如果 Allow 和 Disallow 的顺序颠倒:

用户代理:* 禁止:/admin/

允许:/admin/seo/

爬虫无法访问/admin/目录下的seo文件夹,因为第一个Disallow:/admin/已经匹配成功。

六、关于机器人元

Robots.txt 文件主要限制整个站点或目录的搜索引擎访问,而 Robots Meta 标签主要针对特定页面。与其他META标签(如使用的语言、页面描述、关键词等)一样,Robots Meta标签也放置在页面上,专门告诉搜索引擎ROBOTS如何抓取内容的页面。

Robots Meta标签不区分大小写,name="Robots"表示所有搜索引擎,对于特定搜索引擎(如google)可以写成name="Googlebot"。内容部分有四个命令选项:index、noindex、follow、nofollow,命令之间用“,”分隔。

Index 指令告诉搜索机器人抓取页面;

NoIndex 命令:告诉搜索引擎不要抓取该页面

Follow指令表示搜索机器人可以继续沿着页面上的链接爬行;

NoFollow 命令:告诉搜索引擎不允许从此页面找到链接并拒绝它们进一步访问。

Robots Meta标签的默认值为Index和Follow;

根据上面的命令,我们有以下四种组合:

可以爬取这个页面,并且可以继续索引这个页面上的其他链接=

该页面不允许被爬取,但其他链接可以沿着该页面被爬取和索引

您可以爬取该页面,但不允许爬取该页面上的其他链接进行索引

不要爬取这个页面,也不要沿着这个页面爬取其他链接进行索引。

七、关于 rel="nofollow"

将“nofollow”放在超链接中告诉搜索引擎不要抓取特定链接。

抓取动态网页(搜索引擎来说静态页面的优点和html结尾有什么区别?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 110 次浏览 • 2022-02-14 01:22

首先,原则上我们要知道,静态页面对于搜索引擎来说绝对是最好的,具有最快的抓取和响应速度。另外,伪静态链接本质上是动态链接,只是动态链接是通过相应的算法规则伪装的。进入静态链接,htm或者html结束页面一般都是静态或者伪静态页面。本站采用伪静态处理,一小部分是我自己写的静态页面。zblog 主题静态插件可以在商店中找到并使用。

如何区分网页中的动态链接、伪静态和静态页面?

一、动态链接地址(例如 /?13.sd234554 )

一般来说,带有问号等参数的链接可以称为动态链接。与程序开发相比,这一步一般都会做。

优点:占用空间很小,使用动态页面时文件会很小,因为数据是从数据库中调出来的。如果需要修改某个具体的值,可以直接在数据库上修改,然后所有的动态页面都会自动更新。现在,服务器的数据占用会很小,特别是一些大公司平台本身的数据量是企业级的。

(据我所知,很多b2b平台每次生成一个页面都需要几个小时来更新缓存)

缺点:由于需要进行计算,用户访问速度较慢,动态页面的数据是从数据库中获取的。如果访问者数量很大,对数据库的压力就会很大。虽然目前的动态程序大多使用缓存技术,但总的来说,动态页面对服务器的压力更大。同时,动态页面的网站一般对服务器有更高的要求,同时访问的人越多,对服务器的压力就越大。另外,对于搜索引擎来说,动态页面是非常不友好的,所以也会有爬取和收录,但是和其他静态和伪静态相比,还是少了很多。很多懂SEO的公司都会做伪静态处理。.

二、静态链接地址(例如 /2343.html )

优点:与其他两种动态和伪静态页面相比,静态页面的访问速度最快,而且访问时不需要从数据库中调用数据,不仅访问速度快,而且不会造成服务器上的任何压力。

缺点:由于数据全部存储在HTML中,文件数据非常大。更严重的是,如果需要更改,必须更改所有源代码,而不仅仅是一个地方。而如果是很大的网站,就会有很多数据,占用大部分服务器空间资源,每次添加内容都会生成一个新的静态页面。它比动态和伪静态更麻烦。

三、伪静态链接地址

优点:结合了动态链接和静态链接,主要是让搜索引擎把自己的网页当成静态页面

缺点:如果流量有轻微波动,使用伪静态会导致CPU使用率超载。由于伪静态使用的是正则判断而不是真实地址,所以区分显示哪个页面的职责也是直接指定并转交给CPU,所以CPU占用的增加确实是伪静态最大的缺点。

总结:我个人建议小网站单页,以后很少更新。可以使用静态页面。如果批量多或大网站建议使用伪静态页面,而动态页面适合无搜索引擎爬取。对于需要登录的功能,如注册、会员功能,推荐使用动态页面。

PS:如果肉眼无法判断是静态页面还是伪静态怎么办?我们可以在谷歌浏览器(360也可以使用谷歌内核)、火狐浏览器等中按crtl+shift+j打开控制台,在控制台输入alert()代码,记录当前页面的时间,然后重新输入一次,并再次记录时间。如果每次时间不同,则可以确定该页面为伪静态页面。 查看全部

抓取动态网页(搜索引擎来说静态页面的优点和html结尾有什么区别?)

首先,原则上我们要知道,静态页面对于搜索引擎来说绝对是最好的,具有最快的抓取和响应速度。另外,伪静态链接本质上是动态链接,只是动态链接是通过相应的算法规则伪装的。进入静态链接,htm或者html结束页面一般都是静态或者伪静态页面。本站采用伪静态处理,一小部分是我自己写的静态页面。zblog 主题静态插件可以在商店中找到并使用。

如何区分网页中的动态链接、伪静态和静态页面?

一、动态链接地址(例如 /?13.sd234554 )

一般来说,带有问号等参数的链接可以称为动态链接。与程序开发相比,这一步一般都会做。

优点:占用空间很小,使用动态页面时文件会很小,因为数据是从数据库中调出来的。如果需要修改某个具体的值,可以直接在数据库上修改,然后所有的动态页面都会自动更新。现在,服务器的数据占用会很小,特别是一些大公司平台本身的数据量是企业级的。

(据我所知,很多b2b平台每次生成一个页面都需要几个小时来更新缓存)

缺点:由于需要进行计算,用户访问速度较慢,动态页面的数据是从数据库中获取的。如果访问者数量很大,对数据库的压力就会很大。虽然目前的动态程序大多使用缓存技术,但总的来说,动态页面对服务器的压力更大。同时,动态页面的网站一般对服务器有更高的要求,同时访问的人越多,对服务器的压力就越大。另外,对于搜索引擎来说,动态页面是非常不友好的,所以也会有爬取和收录,但是和其他静态和伪静态相比,还是少了很多。很多懂SEO的公司都会做伪静态处理。.

二、静态链接地址(例如 /2343.html )

优点:与其他两种动态和伪静态页面相比,静态页面的访问速度最快,而且访问时不需要从数据库中调用数据,不仅访问速度快,而且不会造成服务器上的任何压力。

缺点:由于数据全部存储在HTML中,文件数据非常大。更严重的是,如果需要更改,必须更改所有源代码,而不仅仅是一个地方。而如果是很大的网站,就会有很多数据,占用大部分服务器空间资源,每次添加内容都会生成一个新的静态页面。它比动态和伪静态更麻烦。

三、伪静态链接地址

优点:结合了动态链接和静态链接,主要是让搜索引擎把自己的网页当成静态页面

缺点:如果流量有轻微波动,使用伪静态会导致CPU使用率超载。由于伪静态使用的是正则判断而不是真实地址,所以区分显示哪个页面的职责也是直接指定并转交给CPU,所以CPU占用的增加确实是伪静态最大的缺点。

总结:我个人建议小网站单页,以后很少更新。可以使用静态页面。如果批量多或大网站建议使用伪静态页面,而动态页面适合无搜索引擎爬取。对于需要登录的功能,如注册、会员功能,推荐使用动态页面。

PS:如果肉眼无法判断是静态页面还是伪静态怎么办?我们可以在谷歌浏览器(360也可以使用谷歌内核)、火狐浏览器等中按crtl+shift+j打开控制台,在控制台输入alert()代码,记录当前页面的时间,然后重新输入一次,并再次记录时间。如果每次时间不同,则可以确定该页面为伪静态页面。

抓取动态网页(门户网站建设注意事项有哪些?设计门户网站的门户网站有什么)

网站优化 • 优采云 发表了文章 • 0 个评论 • 80 次浏览 • 2022-02-13 03:02

在这个互联网爆炸的时代,学习使用互联网是我们每个人的必修课,因为只有学会使用互联网,我们才能跟上时代的步伐,否则就会被淘汰。目前比较流行的是设计门户网站。它在年轻一代中很受欢迎。设计一个独特的门户网站对于宣传非常有效。那么构建传送门网站有哪些注意事项呢?

1、网站应该有清晰的层次结构和文本链接。每个网页都应该可以通过至少一个静态文本链接打开。文本链接不同于其他代码(如 javascript)生成的链接。本文中的“打印”不是通过文本链接实现的。

2、考虑用户将使用哪些词来查找您的页面,并确保 网站 确实收录这些词。深入了解这一点会让你受益匪浅。

3、网站要实用,内容丰富,网页上的文字要清晰准确地表达要传达的内容。

4、检查链接是否损坏并确保 HTML 格式正确。请使用 Google网站Administrator Tools 随时检查您的 网站 链接,如有损坏,请删除或更正。

5、为用户提供网站 地图,列出网站 重要部分的链接。如果 网站map 有超过或大约 100 个链接,则 网站map 需要拆分为多个页面。

6、门户网站网站尽可能使用文本而不是图形来显示重要的名称、内容或链接。Google 的抓取工具无法识别图形中收录的文字。特别是在附属链接方面,如果您提供公关和排名,使用文本链接很重要。

7、确保TITLE和ALT标签属性的描述和表达是准确的。记得给页面上的图片加上ALT描述,这里是你放关键词的好地方。

8、如果您决定使用动态页面(即,收录“?”字符的 URL),请注意并非所有搜索引擎爬虫都可以爬取动态页面和静态页面。缩短参数长度,减少参数数量对动态页面很有帮助。建议使用 URL 重写技术使动态链接静态化。

关于portal网站搭建的注意事项,需要注意以下几点。首先网站应该有清晰的层次和文字链接,第二网站应该实用且内容丰富,然后尝试使用文字而不是图形来显示重要的名称、内容或链接,最后提出可以使用 URL 重写技术使动态链接静态化。 查看全部

抓取动态网页(门户网站建设注意事项有哪些?设计门户网站的门户网站有什么)

在这个互联网爆炸的时代,学习使用互联网是我们每个人的必修课,因为只有学会使用互联网,我们才能跟上时代的步伐,否则就会被淘汰。目前比较流行的是设计门户网站。它在年轻一代中很受欢迎。设计一个独特的门户网站对于宣传非常有效。那么构建传送门网站有哪些注意事项呢?

1、网站应该有清晰的层次结构和文本链接。每个网页都应该可以通过至少一个静态文本链接打开。文本链接不同于其他代码(如 javascript)生成的链接。本文中的“打印”不是通过文本链接实现的。

2、考虑用户将使用哪些词来查找您的页面,并确保 网站 确实收录这些词。深入了解这一点会让你受益匪浅。

3、网站要实用,内容丰富,网页上的文字要清晰准确地表达要传达的内容。

4、检查链接是否损坏并确保 HTML 格式正确。请使用 Google网站Administrator Tools 随时检查您的 网站 链接,如有损坏,请删除或更正。

5、为用户提供网站 地图,列出网站 重要部分的链接。如果 网站map 有超过或大约 100 个链接,则 网站map 需要拆分为多个页面。

6、门户网站网站尽可能使用文本而不是图形来显示重要的名称、内容或链接。Google 的抓取工具无法识别图形中收录的文字。特别是在附属链接方面,如果您提供公关和排名,使用文本链接很重要。

7、确保TITLE和ALT标签属性的描述和表达是准确的。记得给页面上的图片加上ALT描述,这里是你放关键词的好地方。

8、如果您决定使用动态页面(即,收录“?”字符的 URL),请注意并非所有搜索引擎爬虫都可以爬取动态页面和静态页面。缩短参数长度,减少参数数量对动态页面很有帮助。建议使用 URL 重写技术使动态链接静态化。

关于portal网站搭建的注意事项,需要注意以下几点。首先网站应该有清晰的层次和文字链接,第二网站应该实用且内容丰富,然后尝试使用文字而不是图形来显示重要的名称、内容或链接,最后提出可以使用 URL 重写技术使动态链接静态化。

抓取动态网页(HTML网页中巧用URL的原理及原理分析(一))

网站优化 • 优采云 发表了文章 • 0 个评论 • 100 次浏览 • 2022-02-12 11:22

在 HTML 页面中巧妙地使用 URL:

一、发布地址给大家测试

/test/htmlpro/?name=cnbruce&email=

1.现在流行的(可能是因为最近问的人多了)就是不带文件名的URL地址。例如,htmlpro/? 其实这和服务器设置的默认文件名有关,比如index.htm、index.html、index.asp等,不信可以试试我的一位朋友(asp的)。

2.这里的文件是index.html,后面有参数。页面效果类似于ASP提取信息内容。

以下为转载文章(作者刘晓)可以解释一下

经常上网的朋友一定很熟悉“host/***.asp?arg1=*&arg2=*”等URL(即网址)。这类URL的作用是通过在URL后面附加信息内容,将相关信息传递给远程Web服务器,并在Web服务器进行适当处理后将结果返回给客户端,从而达到网页交互的目的并实现动态网页内容。. (注:URL和信息内容用“?”连接,内容字段用字符“&”分隔,每个字段的名称/值用“name=value”的形式表示。)但是通过这种方式实现的动态网页都需要服务器端编程技术的支持。最近,作者在制作个人网站时使用了浏览器支持的DHTML和XML技术。动态网页。

一、原理分析

当浏览器以这种方式向Web服务器请求时,Web服务器会解析请求地址的URL,将querystring字符串存储在“?”之后。在服务器特定的环境变量中,然后调用服务器端的编程执行环境,如ASP(Activex Server Page)等来处理请求的程序文件。

调用什么样的编程执行环境取决于服务器的设置。如果请求的文档是asp类型的文件,则调用ASP,如果是aspx类型的文件,则调用ASP.NET。在程序文件中,可以通过一定的方法读取环境变量,比如asp文件,可以通过Reques.Querystring数据集合读取环境变量。编程执行环境处理后,将结果返回给Web服务器,Web服务器将结果返回给浏览器,从而达到动态网页内容的目的。

通过上面的分析我们可以知道,如果使用*.htm?querystring方法向Web服务器发送请求,Web服务器会直接将请求的HTML页面返回给浏览器。这时候我们可以使用网页中的Location.href属性来获取带有附加信息内容的URL字符串。经过适当的处理,我们可以得到附加信息内容字段的名称和值,然后利用浏览器支持的DHTML特性进行处理,网页的内容可以是动态的,从而达到不支持服务器端编程技术的免费主页空间上的网页交互。

我们也可以看到,动态网页交互的目的是通过这种方式实现的,即使是在浏览器中实现,也还是摆脱不了web服务器的支持,否则浏览器会把“?querystring”当作请求的 URL 的一部分,因此出现无法查看网页的错误消息。

二、应用实例

--- 下面给出了带有详细注释的具体示例源代码。注意:querystring.js是一个实用程序,可以直接在网页中引用,然后在网页中使用Request["name"]获取用户输入的相关信息内容。

1.querystring.js 源代码

函数查询字符串()

{//构造参数对象并初始化

变量名称,值,我;

var str=location.href;//获取浏览器地址栏的url字符串

var num=str.indexOf("?")

str=str.substr(num+1);//截取“?”后面的参数字符串

var arrtmp=str.split("&");//将各个参数分开,组成参数数组

for(i=0;i < arrtmp.length;i++){

num=arrtmp[i].indexOf("=");

如果(数字>0){

name=arrtmp[i].substring(0,num);//获取参数名称

value=arrtmp[i].substr(num+1);//获取参数值

this[name]=value;//定义对象属性并初始化

}

}

}

var Request=new QueryString();//使用new操作符创建参数对象的实例

2.Sample.htm 源代码

例子

如果使用 DHTML 和 XML 技术扩展此示例,将获得令人难以置信的结果。笔者就是这样在首页空间搭建了一个不错的动态图片查看器,只支持纯HTML 查看全部

抓取动态网页(HTML网页中巧用URL的原理及原理分析(一))

在 HTML 页面中巧妙地使用 URL:

一、发布地址给大家测试

/test/htmlpro/?name=cnbruce&email=

1.现在流行的(可能是因为最近问的人多了)就是不带文件名的URL地址。例如,htmlpro/? 其实这和服务器设置的默认文件名有关,比如index.htm、index.html、index.asp等,不信可以试试我的一位朋友(asp的)。

2.这里的文件是index.html,后面有参数。页面效果类似于ASP提取信息内容。

以下为转载文章(作者刘晓)可以解释一下

经常上网的朋友一定很熟悉“host/***.asp?arg1=*&arg2=*”等URL(即网址)。这类URL的作用是通过在URL后面附加信息内容,将相关信息传递给远程Web服务器,并在Web服务器进行适当处理后将结果返回给客户端,从而达到网页交互的目的并实现动态网页内容。. (注:URL和信息内容用“?”连接,内容字段用字符“&”分隔,每个字段的名称/值用“name=value”的形式表示。)但是通过这种方式实现的动态网页都需要服务器端编程技术的支持。最近,作者在制作个人网站时使用了浏览器支持的DHTML和XML技术。动态网页。

一、原理分析

当浏览器以这种方式向Web服务器请求时,Web服务器会解析请求地址的URL,将querystring字符串存储在“?”之后。在服务器特定的环境变量中,然后调用服务器端的编程执行环境,如ASP(Activex Server Page)等来处理请求的程序文件。

调用什么样的编程执行环境取决于服务器的设置。如果请求的文档是asp类型的文件,则调用ASP,如果是aspx类型的文件,则调用ASP.NET。在程序文件中,可以通过一定的方法读取环境变量,比如asp文件,可以通过Reques.Querystring数据集合读取环境变量。编程执行环境处理后,将结果返回给Web服务器,Web服务器将结果返回给浏览器,从而达到动态网页内容的目的。

通过上面的分析我们可以知道,如果使用*.htm?querystring方法向Web服务器发送请求,Web服务器会直接将请求的HTML页面返回给浏览器。这时候我们可以使用网页中的Location.href属性来获取带有附加信息内容的URL字符串。经过适当的处理,我们可以得到附加信息内容字段的名称和值,然后利用浏览器支持的DHTML特性进行处理,网页的内容可以是动态的,从而达到不支持服务器端编程技术的免费主页空间上的网页交互。

我们也可以看到,动态网页交互的目的是通过这种方式实现的,即使是在浏览器中实现,也还是摆脱不了web服务器的支持,否则浏览器会把“?querystring”当作请求的 URL 的一部分,因此出现无法查看网页的错误消息。

二、应用实例

--- 下面给出了带有详细注释的具体示例源代码。注意:querystring.js是一个实用程序,可以直接在网页中引用,然后在网页中使用Request["name"]获取用户输入的相关信息内容。

1.querystring.js 源代码

函数查询字符串()

{//构造参数对象并初始化

变量名称,值,我;

var str=location.href;//获取浏览器地址栏的url字符串

var num=str.indexOf("?")

str=str.substr(num+1);//截取“?”后面的参数字符串

var arrtmp=str.split("&");//将各个参数分开,组成参数数组

for(i=0;i < arrtmp.length;i++){

num=arrtmp[i].indexOf("=");

如果(数字>0){

name=arrtmp[i].substring(0,num);//获取参数名称

value=arrtmp[i].substr(num+1);//获取参数值

this[name]=value;//定义对象属性并初始化

}

}

}

var Request=new QueryString();//使用new操作符创建参数对象的实例

2.Sample.htm 源代码

例子

如果使用 DHTML 和 XML 技术扩展此示例,将获得令人难以置信的结果。笔者就是这样在首页空间搭建了一个不错的动态图片查看器,只支持纯HTML

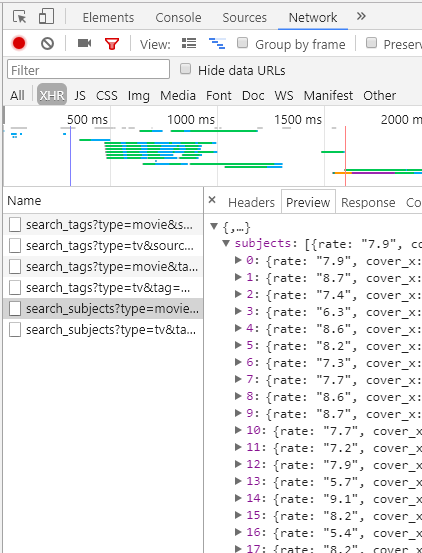

抓取动态网页(具体数据请求的方法:ajax动态加载网页抓取Dwzb)

网站优化 • 优采云 发表了文章 • 0 个评论 • 232 次浏览 • 2022-02-11 23:16

有关如何请求数据的详细信息,请参阅:

ajax动态加载网页抓取

dwzb

统计学学生

25 人点赞文章

AJAX 是一种无需重新加载整个网页即可更新部分网页的技术。

比如打开这个页面,先不要移动,观察右边滚动条的长度,然后当你把滚动条拉到底的时候,滚动条变短了,也就是页面变长了,也就是说,有些数据是这个时候加载的。这个过程是动态加载的,基于ajax技术。我们可以看到,当拉动滚动条时,页面上的数据增加了,但是 URL 并没有改变。它不会像翻页那样将数据存储到另一个网页。现在让我们解释如何爬取这种网页。

本文分为以下几个部分

查看网页源代码的两种方式

首先需要声明的是,在使用浏览器时,两种查看网页源代码的方式是不同的。这里我们使用chrome浏览器来说明。

首先是右键检查,在 element 中查看网页的源代码,这种模式具有折叠和选择的功能,对于我们找到位置抓取信息非常有帮助。这里的源码就是我们面前当前显示的页面对应的源码。

二是右键-查看网页源代码,是网页真正的源代码,请求网页得到的源代码(r.text)与此如出一辙。

大多数情况下,这两个位置显示的源代码完全相同,但有时也存在差异。例如,在当前的动态加载示例中,当我拉下滚轮时,会重新加载新数据。这部分数据会出现在“检查”的源代码中,但不会出现在“查看页面源代码”中。. 后者是这个URL的原创源代码,不会被后面执行的JS程序改变,而“check”中的源代码和当前页面是一样的,是执行了一些JS代码后重新生成的源代码. 代码。

有时会发生两个位置的源代码几乎相同,但在一些小标签属性或某个值上存在差异。在解析网页的时候,我们经常会以“check”中的源码为基础。当我们觉得解析代码没有问题,但又找不到什么(或有什么不对)时,可以考虑去“查看网页源代码”。那个页面,是不是有一个小地方的区别。

比如拿一个链家二手房的页面,看这里的“税费”,你先刷新页面观察这个位置,你会发现它会先加载13.8,然后变成 45.@ >

两种方式查看源码都会发现勾选是45,查看页面源码是13.8不变。所以,如果你想爬这个网站,不做任何处理,你会得到13.8,这是链家故意给你的假数据。

言归正传,如果我们要捕获这个网页的数据,如果我们像以前一样只提取r.text来解析网页,我们只能得到一开始加载的数据,如何才能将所有数据捕获到稍后加载这就是我们要在这里讨论的内容。

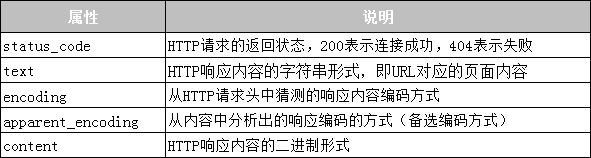

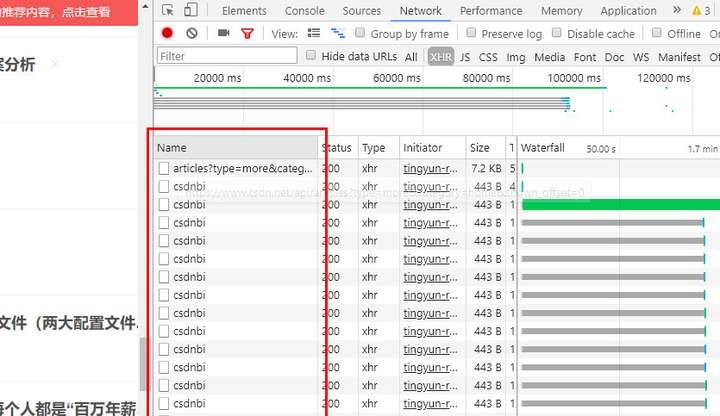

分析网页请求

我们在页面中右键--勾选,选择network,选择XHR,将左侧网页的滚动条拖到底部加载新数据,可以看到network中出现了一个新文件

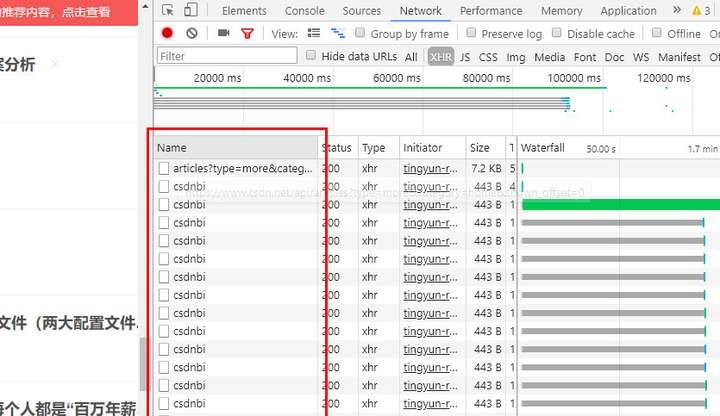

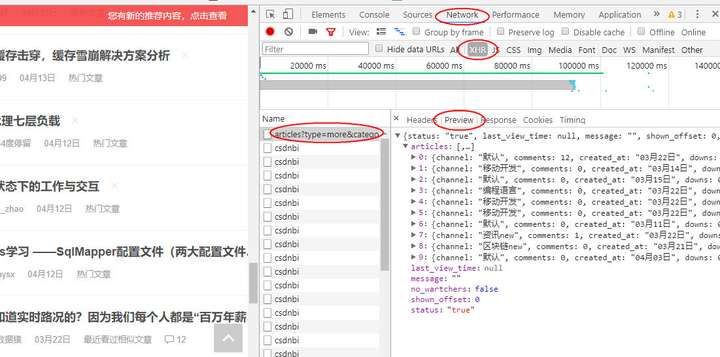

这些是你拖动时浏览器对网页的新请求,加载的数据就是从这个请求中获取的。也就是说,我们可以在这些新加载的文件中找到我们想要的数据。根据经验数据,它存在于第一个URL中。点击这个网址,可以看到如下图(读者可以点击其他网址,会发现其他文件对我们抓取数据没有帮助)

preview 指示此 URL 的内容是什么。从上图可以看出,这是json格式的数据。我们可以展开每一项来看看里面有什么信息。

可以看到我们想要的关于文章的所有信息都在这里了,有些字段没有显示在网页上。对于这部分信息,我们只能根据里面的键值对名称来猜测这个字段是什么。意思是。

接下来我们可以请求这个URL获取数据,在headers中可以查看到URL

从json中提取信息会比解析网页容易很多,所以以后遇到爬虫任务时,首先检查网页请求中是否有类似的文件,如果有,可以直接请求这种json文件而不用逐步解析网页。.

一般这种json文件在XHR中很容易找到,但不排除有时需要全部找到这样的文件。

请求的文件通常非常大。没有方向的时候,只能一个一个的点击,但也不麻烦。每个网址都关注预览。json格式的数据就像刚才一样,其实很明显。

接下来,让我们编写代码来抓取数据。

抓取一页数据

现在假设我们只想要文章这个标题,我们只需要在XHR中请求那个URL,然后像字典一样处理得到的内容,代码如下

import requests

headers = {'cookie':'', # 传入你的cookies

'user-agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/65.0.3325.181 Safari/537.36'}

def get_page():

r = requests.get('https://www.csdn.net/api/artic ... 39%3B,

headers = headers)

d = r.json()

articles = d['articles']

for article in articles:

yield article['title']

for i in get_page():

print(i)

其中r.json是将json格式的字符串转换成python对象,这里是转换成字典。(读者可以尝试调用r.text,发现是json字符串,可以用json模块中的json.loads转换成字典对象,但是requests中提供的.json()使用起来更方便)

注意:如果您不使用cookies,您将无法获得主页上显示的数据。因此,即使您没有登录,也可以复制 cookie。

接下来让我们获取所有数据。

页面更新策略

当我们再次拉下页面时,我们会发现加载了一个新的 URL。

看它的headers,惊奇的发现和上一个一模一样,再看它的request headers,几乎是一样的,所以我们可以尝试连续两次请求这个页面,看看有没有我们得到不同的数据——真正不同的数据。

所以我们可以设置一个爬取策略:一直访问这个URL,直到获取不到数据为止。

我们连续请求20次,代码如下

import requests

headers = {'cookie':'', # 传入你的cookies

'user-agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/65.0.3325.181 Safari/537.36'}

def get_page():

r = requests.get('https://www.csdn.net/api/artic ... 39%3B,

headers = headers)

d = r.json()

articles = d['articles']

print(len(articles)) # 每次看抓取到了多少信息

for article in articles:

yield article['title']

def get_pages():

for i in range(20):

yield from get_page()

l = list(get_pages())

len(l) # 看总共抓了多少条

这段代码的结果是,在20个请求中,前15次获取到10条数据,后5次没有获取到数据,说明我们只能获取到150条信息。

这时候我们再看浏览器,会发现滚动条不会加载新的数据,刷新网页就会得到这个界面。

这意味着你的爬虫已经用尽了这个cookie,浏览器无法使用这个cookie获取数据,需要一段时间才能发出请求。

其他例子

ajax加载的页面的爬取是类似的,可能只是不同网站每个加载URL的设计不同。让我们再举一些例子

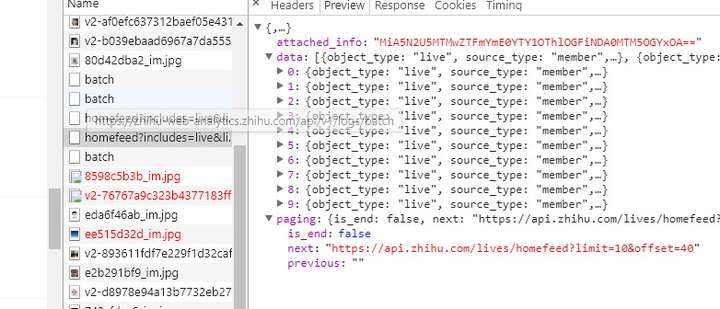

知乎live,它也是用鼠标下拉页面加载新数据,我们会怀疑是ajax加载的。同理可以找到如下文件

可以看到比CSDN多了一个字段分页,显示本页是否为最后一页,下一页的链接是什么。这样我们只需要像上图那样下拉一次就可以得到页面,然后请求页面,获取数据和下一页的url,然后请求下一页,获取数据并获取下一页,并通过判断is_end结束循环。

换句话说,我们可以查看当前 URL 和下一个 URL 之间是否存在模式,并通过构造 URL 进行循环。

如果读者没有尝试过,他可能会怀疑这里的下一页是否真的是下一页的数据。然后可以多次下拉网页,看后面的网址是不是前面的下一个。

知乎live 这种形式的 ajax 加载内容和 URL 设计应该是最常见的。我们可以看到它的URL其实就是知乎的API(看那个URL的域名),也就是我们浏览网页的时候,页面就是请求API得到的数据。API可以理解为一个数据接口,通过请求这个URL就可以得到对应的数据,那么这个URL就是一个接口。本专栏后面会写一篇文章文章来介绍API。

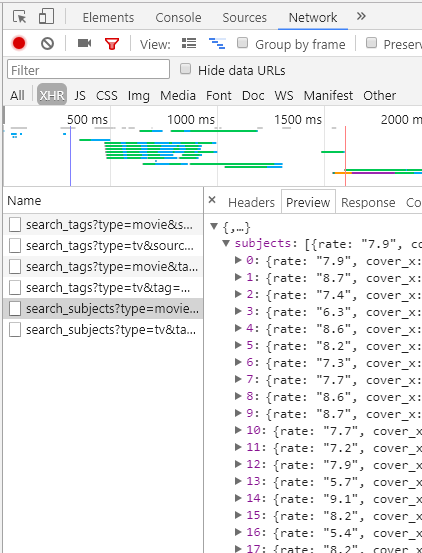

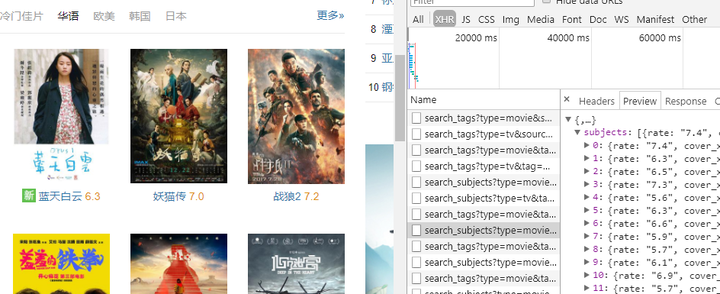

2.豆瓣电影

点击上面的标签:电影、热门、最新、豆瓣高分等。每次点击,你会发现浏览器中显示的网址没有变化,包括点击下面的点翻页,网址有没变,也就是说这里的数据可能是用ajax加载的,看下检查网络的XHR

发现数据确实是用ajax加载的,我们只需要请求这个URL就可以获取数据。

这时候我们选择最新和豆瓣高分标签,可以看到XHR中加载了一个新文件,如下图

只要我们分析这些文件的URL的规律性,我们就可以在这个窗口中抓取所有标签的电影数据。 查看全部

抓取动态网页(具体数据请求的方法:ajax动态加载网页抓取Dwzb)

有关如何请求数据的详细信息,请参阅:

ajax动态加载网页抓取

dwzb

统计学学生

25 人点赞文章

AJAX 是一种无需重新加载整个网页即可更新部分网页的技术。

比如打开这个页面,先不要移动,观察右边滚动条的长度,然后当你把滚动条拉到底的时候,滚动条变短了,也就是页面变长了,也就是说,有些数据是这个时候加载的。这个过程是动态加载的,基于ajax技术。我们可以看到,当拉动滚动条时,页面上的数据增加了,但是 URL 并没有改变。它不会像翻页那样将数据存储到另一个网页。现在让我们解释如何爬取这种网页。

本文分为以下几个部分

查看网页源代码的两种方式

首先需要声明的是,在使用浏览器时,两种查看网页源代码的方式是不同的。这里我们使用chrome浏览器来说明。

首先是右键检查,在 element 中查看网页的源代码,这种模式具有折叠和选择的功能,对于我们找到位置抓取信息非常有帮助。这里的源码就是我们面前当前显示的页面对应的源码。

二是右键-查看网页源代码,是网页真正的源代码,请求网页得到的源代码(r.text)与此如出一辙。

大多数情况下,这两个位置显示的源代码完全相同,但有时也存在差异。例如,在当前的动态加载示例中,当我拉下滚轮时,会重新加载新数据。这部分数据会出现在“检查”的源代码中,但不会出现在“查看页面源代码”中。. 后者是这个URL的原创源代码,不会被后面执行的JS程序改变,而“check”中的源代码和当前页面是一样的,是执行了一些JS代码后重新生成的源代码. 代码。

有时会发生两个位置的源代码几乎相同,但在一些小标签属性或某个值上存在差异。在解析网页的时候,我们经常会以“check”中的源码为基础。当我们觉得解析代码没有问题,但又找不到什么(或有什么不对)时,可以考虑去“查看网页源代码”。那个页面,是不是有一个小地方的区别。

比如拿一个链家二手房的页面,看这里的“税费”,你先刷新页面观察这个位置,你会发现它会先加载13.8,然后变成 45.@ >

两种方式查看源码都会发现勾选是45,查看页面源码是13.8不变。所以,如果你想爬这个网站,不做任何处理,你会得到13.8,这是链家故意给你的假数据。

言归正传,如果我们要捕获这个网页的数据,如果我们像以前一样只提取r.text来解析网页,我们只能得到一开始加载的数据,如何才能将所有数据捕获到稍后加载这就是我们要在这里讨论的内容。

分析网页请求

我们在页面中右键--勾选,选择network,选择XHR,将左侧网页的滚动条拖到底部加载新数据,可以看到network中出现了一个新文件

这些是你拖动时浏览器对网页的新请求,加载的数据就是从这个请求中获取的。也就是说,我们可以在这些新加载的文件中找到我们想要的数据。根据经验数据,它存在于第一个URL中。点击这个网址,可以看到如下图(读者可以点击其他网址,会发现其他文件对我们抓取数据没有帮助)

preview 指示此 URL 的内容是什么。从上图可以看出,这是json格式的数据。我们可以展开每一项来看看里面有什么信息。

可以看到我们想要的关于文章的所有信息都在这里了,有些字段没有显示在网页上。对于这部分信息,我们只能根据里面的键值对名称来猜测这个字段是什么。意思是。

接下来我们可以请求这个URL获取数据,在headers中可以查看到URL

从json中提取信息会比解析网页容易很多,所以以后遇到爬虫任务时,首先检查网页请求中是否有类似的文件,如果有,可以直接请求这种json文件而不用逐步解析网页。.

一般这种json文件在XHR中很容易找到,但不排除有时需要全部找到这样的文件。

请求的文件通常非常大。没有方向的时候,只能一个一个的点击,但也不麻烦。每个网址都关注预览。json格式的数据就像刚才一样,其实很明显。

接下来,让我们编写代码来抓取数据。

抓取一页数据

现在假设我们只想要文章这个标题,我们只需要在XHR中请求那个URL,然后像字典一样处理得到的内容,代码如下

import requests

headers = {'cookie':'', # 传入你的cookies

'user-agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/65.0.3325.181 Safari/537.36'}

def get_page():

r = requests.get('https://www.csdn.net/api/artic ... 39%3B,

headers = headers)

d = r.json()

articles = d['articles']

for article in articles:

yield article['title']

for i in get_page():

print(i)

其中r.json是将json格式的字符串转换成python对象,这里是转换成字典。(读者可以尝试调用r.text,发现是json字符串,可以用json模块中的json.loads转换成字典对象,但是requests中提供的.json()使用起来更方便)

注意:如果您不使用cookies,您将无法获得主页上显示的数据。因此,即使您没有登录,也可以复制 cookie。

接下来让我们获取所有数据。

页面更新策略

当我们再次拉下页面时,我们会发现加载了一个新的 URL。

看它的headers,惊奇的发现和上一个一模一样,再看它的request headers,几乎是一样的,所以我们可以尝试连续两次请求这个页面,看看有没有我们得到不同的数据——真正不同的数据。

所以我们可以设置一个爬取策略:一直访问这个URL,直到获取不到数据为止。

我们连续请求20次,代码如下

import requests

headers = {'cookie':'', # 传入你的cookies

'user-agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/65.0.3325.181 Safari/537.36'}

def get_page():

r = requests.get('https://www.csdn.net/api/artic ... 39%3B,

headers = headers)

d = r.json()

articles = d['articles']

print(len(articles)) # 每次看抓取到了多少信息

for article in articles:

yield article['title']

def get_pages():

for i in range(20):

yield from get_page()

l = list(get_pages())

len(l) # 看总共抓了多少条

这段代码的结果是,在20个请求中,前15次获取到10条数据,后5次没有获取到数据,说明我们只能获取到150条信息。

这时候我们再看浏览器,会发现滚动条不会加载新的数据,刷新网页就会得到这个界面。

这意味着你的爬虫已经用尽了这个cookie,浏览器无法使用这个cookie获取数据,需要一段时间才能发出请求。

其他例子

ajax加载的页面的爬取是类似的,可能只是不同网站每个加载URL的设计不同。让我们再举一些例子

知乎live,它也是用鼠标下拉页面加载新数据,我们会怀疑是ajax加载的。同理可以找到如下文件

可以看到比CSDN多了一个字段分页,显示本页是否为最后一页,下一页的链接是什么。这样我们只需要像上图那样下拉一次就可以得到页面,然后请求页面,获取数据和下一页的url,然后请求下一页,获取数据并获取下一页,并通过判断is_end结束循环。

换句话说,我们可以查看当前 URL 和下一个 URL 之间是否存在模式,并通过构造 URL 进行循环。

如果读者没有尝试过,他可能会怀疑这里的下一页是否真的是下一页的数据。然后可以多次下拉网页,看后面的网址是不是前面的下一个。

知乎live 这种形式的 ajax 加载内容和 URL 设计应该是最常见的。我们可以看到它的URL其实就是知乎的API(看那个URL的域名),也就是我们浏览网页的时候,页面就是请求API得到的数据。API可以理解为一个数据接口,通过请求这个URL就可以得到对应的数据,那么这个URL就是一个接口。本专栏后面会写一篇文章文章来介绍API。

2.豆瓣电影

点击上面的标签:电影、热门、最新、豆瓣高分等。每次点击,你会发现浏览器中显示的网址没有变化,包括点击下面的点翻页,网址有没变,也就是说这里的数据可能是用ajax加载的,看下检查网络的XHR

发现数据确实是用ajax加载的,我们只需要请求这个URL就可以获取数据。

这时候我们选择最新和豆瓣高分标签,可以看到XHR中加载了一个新文件,如下图

只要我们分析这些文件的URL的规律性,我们就可以在这个窗口中抓取所有标签的电影数据。

抓取动态网页(SEO优化的基础与技巧抓取网页覆盖率的重要性)

网站优化 • 优采云 发表了文章 • 0 个评论 • 66 次浏览 • 2022-02-11 08:14

搜索引擎蜘蛛是搜索引擎的信息来源。对于网站站长来说,我一直希望网站能够对搜索引擎蜘蛛友好,也希望蜘蛛能够在自己的网站中停留更长时间,爬取更多的网页。其实这些蜘蛛并不想爬更多的页面,更新更多的页面,但是互联网信息实在是太大了,有时候蜘蛛是力不从心的。这导致对搜索引擎蜘蛛的评估。蜘蛛每天也在努力工作,也需要被评估和评估。主要评估标准有3个:爬取网页的覆盖率和爬取网页的及时性。以及爬网的重要性。SEO优化基础和技巧

抓取页面覆盖率

对于目前的搜索引擎来说,还没有一个搜索引擎可以爬取互联网上出现的所有网页。所有搜索引擎只能索引互联网的一部分。这里有一个概念——“暗网”,指的是目前搜索引擎蜘蛛很难通过常规方法抓取互联网页面。蜘蛛依靠页面中的链接来寻找新的页面,然后爬取和索引,但是很多页面内容都存储在数据库中。这样,蜘蛛很难或不可能抓取这些信息,导致用户无法在搜索引擎中找到这些信息。SEO优化的技巧有哪些

爬取网页覆盖率是指蜘蛛爬取的网页数量与互联网上所有网页数量的比值。显然,覆盖率越高,搜索引擎可以索引和排名的数量级就越大,参与比较显示搜索的能力就越大。结果越多,用户搜索体验就越好。因此,为了让用户在搜索时获得更准确、更全面的结果,最大化爬取网页的覆盖率是非常重要的。除了爬取方式的改进,暗网数据的爬取已经成为主要的搜索引擎。重要的研究方向。SEO的艺术

可见,爬取网页的覆盖率是评价搜索引擎蜘蛛的一个关键标准。这是一个很大的基数,关系到索引量、排序量和展示量,对用户的搜索体验非常重要。SEO 视频教程

爬取网页时效

就用户的搜索体验而言,网页的时效性比覆盖语句更直观。例如,如果您在搜索结果中找到一个结果,则单击该页面时该页面不存在。你觉得怎么样?搜索引擎都在试图避免这些,所以蜘蛛抓取网页的及时性也是一个重要的检查点。网上资料很多,蜘蛛爬一圈要花很长时间。许多在此时间之前已被索引的网页可能已更改或被删除,这导致某些搜索结果是过时的数据。SEO优化技巧

一句话,蜘蛛无法在网页一更改就将这些更改反映到网页库中,所以问题就来了。首先,如果只是页面内容发生变化,搜索引擎无法及时重新比较这些变化,从而为用户提供更多信息。合理的排名。其次,如果排在搜索结果前面的页面被删除了,但由于没有及时获取和更新,仍然排在重要的位置,那么这无疑对用户是一种伤害。最后很多人会在页面收录后面加上一些不好的信息,让当前信息跟之前的排名一起显示,处理下一次蜘蛛更新。正确认识SEO优化技巧

因此,对于搜索引擎来说,绝对希望数据库中的网页能够及时更新。网页数据库中的过期数据越少,网页的时效性就越好,这对用户体验的影响是不言而喻的。SEO优化技巧

爬网的重要性

蜘蛛爬取了很多内容,并及时更新,但是如果爬取一些低质量的内容,肯定是不行的。虽然需要更频繁地爬取,但每个网页的重要性差异很大。这就是矛盾所在。搜索引擎蜘蛛不仅应该做得更多,做得更快,而且做得很好。所以,一定要优先考虑一些经常能产出优质内容的网站,尤其是定期定量更新的,这样才能最大程度的保证优质内容不被错过,这样可以也可以说是没有办法。如果搜索引擎蜘蛛检索到的网页大多是比较重要的网页,那么可以说它在抓取网页的重要性方面做得很好。搜索引擎优化交流

总而言之,由于种种原因,目前的搜索引擎蜘蛛只能抓取互联网上的部分网页,所以在尝试抓取尽可能多的页面的同时,会尽量选择页面中比较重要的部分进行索引,以及已经抓取的页面。获取的网页也将尽快更新其内容。请注意,所有这些都是尽可能多的,因此这是主要搜索引擎正在尝试做的事情。如果这三个方面都做好了,搜索引擎的用户体验肯定会更好。SEO优化技巧大全

写在最后

搜索引擎在以上三个标准上一直在努力,也号召站长们一起来做。比如百度站长平台的数据提交可以很好的扩大百度蜘蛛抓取的覆盖范围,百度鼓励站长开展网页。提交或者直接提交sitemap,对于蜘蛛抓取更新也非常方便。搜索引擎蜘蛛的工作很累人。它必须做很多事情,而且必须快速而顺利地完成。这一点都不容易。所以,网站站长首先要让网站的链接路径容易爬取,结构平坦,让蜘蛛在有限的时间内爬到更多的东西,让蜘蛛在你的< @网站 多做多做快,定期更新优质内容,这样蜘蛛可以在你身上做得很好,所以随着时间的推移,你 网站 中的蜘蛛会做得更多,更快,做得更好。如果 网站 的结构混乱,总是更新垃圾邮件或不更新,那么蜘蛛将不得不停下来,因为它也必须工作。

文章 由百度网盘精品主办,新片论坛发布,感谢合作! 查看全部

抓取动态网页(SEO优化的基础与技巧抓取网页覆盖率的重要性)

搜索引擎蜘蛛是搜索引擎的信息来源。对于网站站长来说,我一直希望网站能够对搜索引擎蜘蛛友好,也希望蜘蛛能够在自己的网站中停留更长时间,爬取更多的网页。其实这些蜘蛛并不想爬更多的页面,更新更多的页面,但是互联网信息实在是太大了,有时候蜘蛛是力不从心的。这导致对搜索引擎蜘蛛的评估。蜘蛛每天也在努力工作,也需要被评估和评估。主要评估标准有3个:爬取网页的覆盖率和爬取网页的及时性。以及爬网的重要性。SEO优化基础和技巧

抓取页面覆盖率

对于目前的搜索引擎来说,还没有一个搜索引擎可以爬取互联网上出现的所有网页。所有搜索引擎只能索引互联网的一部分。这里有一个概念——“暗网”,指的是目前搜索引擎蜘蛛很难通过常规方法抓取互联网页面。蜘蛛依靠页面中的链接来寻找新的页面,然后爬取和索引,但是很多页面内容都存储在数据库中。这样,蜘蛛很难或不可能抓取这些信息,导致用户无法在搜索引擎中找到这些信息。SEO优化的技巧有哪些

爬取网页覆盖率是指蜘蛛爬取的网页数量与互联网上所有网页数量的比值。显然,覆盖率越高,搜索引擎可以索引和排名的数量级就越大,参与比较显示搜索的能力就越大。结果越多,用户搜索体验就越好。因此,为了让用户在搜索时获得更准确、更全面的结果,最大化爬取网页的覆盖率是非常重要的。除了爬取方式的改进,暗网数据的爬取已经成为主要的搜索引擎。重要的研究方向。SEO的艺术

可见,爬取网页的覆盖率是评价搜索引擎蜘蛛的一个关键标准。这是一个很大的基数,关系到索引量、排序量和展示量,对用户的搜索体验非常重要。SEO 视频教程

爬取网页时效

就用户的搜索体验而言,网页的时效性比覆盖语句更直观。例如,如果您在搜索结果中找到一个结果,则单击该页面时该页面不存在。你觉得怎么样?搜索引擎都在试图避免这些,所以蜘蛛抓取网页的及时性也是一个重要的检查点。网上资料很多,蜘蛛爬一圈要花很长时间。许多在此时间之前已被索引的网页可能已更改或被删除,这导致某些搜索结果是过时的数据。SEO优化技巧

一句话,蜘蛛无法在网页一更改就将这些更改反映到网页库中,所以问题就来了。首先,如果只是页面内容发生变化,搜索引擎无法及时重新比较这些变化,从而为用户提供更多信息。合理的排名。其次,如果排在搜索结果前面的页面被删除了,但由于没有及时获取和更新,仍然排在重要的位置,那么这无疑对用户是一种伤害。最后很多人会在页面收录后面加上一些不好的信息,让当前信息跟之前的排名一起显示,处理下一次蜘蛛更新。正确认识SEO优化技巧

因此,对于搜索引擎来说,绝对希望数据库中的网页能够及时更新。网页数据库中的过期数据越少,网页的时效性就越好,这对用户体验的影响是不言而喻的。SEO优化技巧

爬网的重要性

蜘蛛爬取了很多内容,并及时更新,但是如果爬取一些低质量的内容,肯定是不行的。虽然需要更频繁地爬取,但每个网页的重要性差异很大。这就是矛盾所在。搜索引擎蜘蛛不仅应该做得更多,做得更快,而且做得很好。所以,一定要优先考虑一些经常能产出优质内容的网站,尤其是定期定量更新的,这样才能最大程度的保证优质内容不被错过,这样可以也可以说是没有办法。如果搜索引擎蜘蛛检索到的网页大多是比较重要的网页,那么可以说它在抓取网页的重要性方面做得很好。搜索引擎优化交流

总而言之,由于种种原因,目前的搜索引擎蜘蛛只能抓取互联网上的部分网页,所以在尝试抓取尽可能多的页面的同时,会尽量选择页面中比较重要的部分进行索引,以及已经抓取的页面。获取的网页也将尽快更新其内容。请注意,所有这些都是尽可能多的,因此这是主要搜索引擎正在尝试做的事情。如果这三个方面都做好了,搜索引擎的用户体验肯定会更好。SEO优化技巧大全

写在最后

搜索引擎在以上三个标准上一直在努力,也号召站长们一起来做。比如百度站长平台的数据提交可以很好的扩大百度蜘蛛抓取的覆盖范围,百度鼓励站长开展网页。提交或者直接提交sitemap,对于蜘蛛抓取更新也非常方便。搜索引擎蜘蛛的工作很累人。它必须做很多事情,而且必须快速而顺利地完成。这一点都不容易。所以,网站站长首先要让网站的链接路径容易爬取,结构平坦,让蜘蛛在有限的时间内爬到更多的东西,让蜘蛛在你的< @网站 多做多做快,定期更新优质内容,这样蜘蛛可以在你身上做得很好,所以随着时间的推移,你 网站 中的蜘蛛会做得更多,更快,做得更好。如果 网站 的结构混乱,总是更新垃圾邮件或不更新,那么蜘蛛将不得不停下来,因为它也必须工作。

文章 由百度网盘精品主办,新片论坛发布,感谢合作!

抓取动态网页(动态网站与静态网站区别(1)_官方网站建设)

网站优化 • 优采云 发表了文章 • 0 个评论 • 77 次浏览 • 2022-02-10 21:01

什么是静态 网站?

A:静态的网站是指由一些手写的网站组成的网站。

(1)Static网站不能简单理解为静态网站,他主要是说网站里面没有程序代码,只有HTML(即:超文本标记)语言),一般后缀为.html、.htm或.xml等。虽然静态网站页面的内容一旦创建就不会改变。不过静态的网站也包括一些动态的部分,这些主要是一些动画gif等。

(2)静态网站打开,用户可以直接双击,任何人随时打开的页面内容都将保持不变。

什么是动态网站?

A:动态网站指的是动态程序网站自动生成的网站。

(1)动态网站指的是一种网站编程技术,与静态网站相对。除了HTML标签,动态网站的网站文件@> 此外,它还收录一些具有特定功能的程序代码,可以使浏览器和服务器交互,从而服务器可以根据客户端的不同请求动态生成网站内容。

即:动态网站相对于静态网站,虽然页面代码没有变化,但显示的内容会随着时间、环境或数据库操作的结果而变化。

(2)动态网站与网站上的各种动画、滚动字幕等视觉动态效果没有直接关系,动态网站也可以是纯文字内容,它可以也可以是收录各种动画的内容,这些只是具体内容的网站表达式,不管网站是否有动态效果,只要动态网站技术(如PHP,< ASP、JSP等生成的@网站)可以称为动态网站。

动态网站和静态网站的区别

(1)学习难度:

静态网站制作简单,只要学过HTML5+CSS3,就可以制作静态网站,但是功能单一,没有管理后台,维护特别麻烦,和用户交互不可能。

动态网站制作难度较大,但功能强大,有管理后台,非常容易维护,用户可以交互。

(2)更新与维护:

一旦静态 网站 内容发布到 网站 服务器上,无论是否被用户访问,网站 内容都将存储在 网站 服务器上。如果要修改网站的内容,必须修改其源代码,重新上传到服务器。静态 网站 没有数据库支持。当网站信息量很大时,很难制作和维护网站

动态网站可以根据不同的用户请求、时间或环境要求动态生成不同的网站内容,而动态网站一般是基于数据库技术的,可以大大减少网站维护工作量

(3)交互性:

静态网站因为很多内容是固定的,功能上存在很大限制,所以交互性很差

动态网站可以实现更多功能,如用户登录、注册、查询等。

(4)响应速度:

静态网站内容比较固定,容易被搜索引擎检索到,不需要连接数据库,所以响应速度比较快

动态 网站 实际上并不是服务器上独立存在的 网站 文件。只有当用户请求时,服务器才会返回一个完整的网站,这涉及到数据连接的访问和查询。等待一系列进程,所以响应速度比较慢

(5)访问功能:

静态网站的每一个网站都有一个固定的URL,网站的URL后缀为.htm、.html、.shtml等常用形式,不带“?”。可以直接双击打开

这 ”?” 在动态网站对搜索引擎有一定的问题。一般来说,搜索引擎不可能从网站的数据库中访问所有网站,或者出于技术考虑,“?”后面的内容是不可能的。搜索过程中不抓取网址中的,不能直接双击打开。 查看全部

抓取动态网页(动态网站与静态网站区别(1)_官方网站建设)

什么是静态 网站?

A:静态的网站是指由一些手写的网站组成的网站。

(1)Static网站不能简单理解为静态网站,他主要是说网站里面没有程序代码,只有HTML(即:超文本标记)语言),一般后缀为.html、.htm或.xml等。虽然静态网站页面的内容一旦创建就不会改变。不过静态的网站也包括一些动态的部分,这些主要是一些动画gif等。

(2)静态网站打开,用户可以直接双击,任何人随时打开的页面内容都将保持不变。

什么是动态网站?

A:动态网站指的是动态程序网站自动生成的网站。

(1)动态网站指的是一种网站编程技术,与静态网站相对。除了HTML标签,动态网站的网站文件@> 此外,它还收录一些具有特定功能的程序代码,可以使浏览器和服务器交互,从而服务器可以根据客户端的不同请求动态生成网站内容。

即:动态网站相对于静态网站,虽然页面代码没有变化,但显示的内容会随着时间、环境或数据库操作的结果而变化。

(2)动态网站与网站上的各种动画、滚动字幕等视觉动态效果没有直接关系,动态网站也可以是纯文字内容,它可以也可以是收录各种动画的内容,这些只是具体内容的网站表达式,不管网站是否有动态效果,只要动态网站技术(如PHP,< ASP、JSP等生成的@网站)可以称为动态网站。

动态网站和静态网站的区别

(1)学习难度:

静态网站制作简单,只要学过HTML5+CSS3,就可以制作静态网站,但是功能单一,没有管理后台,维护特别麻烦,和用户交互不可能。

动态网站制作难度较大,但功能强大,有管理后台,非常容易维护,用户可以交互。

(2)更新与维护:

一旦静态 网站 内容发布到 网站 服务器上,无论是否被用户访问,网站 内容都将存储在 网站 服务器上。如果要修改网站的内容,必须修改其源代码,重新上传到服务器。静态 网站 没有数据库支持。当网站信息量很大时,很难制作和维护网站

动态网站可以根据不同的用户请求、时间或环境要求动态生成不同的网站内容,而动态网站一般是基于数据库技术的,可以大大减少网站维护工作量

(3)交互性:

静态网站因为很多内容是固定的,功能上存在很大限制,所以交互性很差

动态网站可以实现更多功能,如用户登录、注册、查询等。

(4)响应速度:

静态网站内容比较固定,容易被搜索引擎检索到,不需要连接数据库,所以响应速度比较快

动态 网站 实际上并不是服务器上独立存在的 网站 文件。只有当用户请求时,服务器才会返回一个完整的网站,这涉及到数据连接的访问和查询。等待一系列进程,所以响应速度比较慢

(5)访问功能:

静态网站的每一个网站都有一个固定的URL,网站的URL后缀为.htm、.html、.shtml等常用形式,不带“?”。可以直接双击打开

这 ”?” 在动态网站对搜索引擎有一定的问题。一般来说,搜索引擎不可能从网站的数据库中访问所有网站,或者出于技术考虑,“?”后面的内容是不可能的。搜索过程中不抓取网址中的,不能直接双击打开。

抓取动态网页(并不一定动态网站URL搜索引擎对动态网页检索的重要作用(图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 368 次浏览 • 2022-02-09 10:16

目前大部分站长不喜欢使用动态页面,因为动态页面会对搜索引擎不友好,所以站长喜欢使用静态代码。现在搜索引擎可以识别和爬取动态页面,也许动态页面将来会成为互联网的主流,所以不一定动态网站不能被搜索引擎排名或搜索到收录 ,只要你掌握了一些技巧。

1、合理安排网站网址

搜索引擎难以检索动态网页的原因是它们对 URL 中的特殊字符不敏感,所以我们应该将网页设为静态,并尽量避免使用“?”等 URL。网站 中的“&”等特殊字符,尤其是“&”是不能接受的。还有一点就是尽量不要在URL中收录汉字,因为浏览器会对URL中的汉字进行编码。如果编码后的网址中汉字过多,则网址会很长,对搜索引擎检索页面非常不利。

2、用好剑“称号”

标题标签对提升网站的排名起到非常重要的作用。很多人害怕动态网站的原因是不知道如何为自动生成的动态页面自动生成合适的title标签。其实这里有个小窍门,就是在title标签前面写SELET,比如一个新闻类别的网站,通常在新闻列表页这样写:"",也就是pass带有ID参数的“>”进入“news_detail.asp”页面查看整个新闻信息,所以我们要做的工作都在news_detail.asp页面中。我们也可以使用这种方法来写描述和关键词。当然,这里有一点要提一下,大家请注意,关键词的作用已经微乎其微,如果使用不当,

3、创建静态条目:

在“动静结合,静制动”的原则指导下,我们还可以对网站进行一些修改,尽可能增加动态网页的搜索引擎可见度。例如,如果将动态网页编入静态主页或网站地图中的链接,则动态网页将以静态目录的形式呈现。或者为动态页面建立一个专门的静态入口页面(网关/入口,链接到动态页面),然后将静态入口页面提交给搜索引擎。

以上三点是给大家如何优化动态网站的建议,希望对大家有所帮助! 查看全部

抓取动态网页(并不一定动态网站URL搜索引擎对动态网页检索的重要作用(图))

目前大部分站长不喜欢使用动态页面,因为动态页面会对搜索引擎不友好,所以站长喜欢使用静态代码。现在搜索引擎可以识别和爬取动态页面,也许动态页面将来会成为互联网的主流,所以不一定动态网站不能被搜索引擎排名或搜索到收录 ,只要你掌握了一些技巧。

1、合理安排网站网址

搜索引擎难以检索动态网页的原因是它们对 URL 中的特殊字符不敏感,所以我们应该将网页设为静态,并尽量避免使用“?”等 URL。网站 中的“&”等特殊字符,尤其是“&”是不能接受的。还有一点就是尽量不要在URL中收录汉字,因为浏览器会对URL中的汉字进行编码。如果编码后的网址中汉字过多,则网址会很长,对搜索引擎检索页面非常不利。

2、用好剑“称号”

标题标签对提升网站的排名起到非常重要的作用。很多人害怕动态网站的原因是不知道如何为自动生成的动态页面自动生成合适的title标签。其实这里有个小窍门,就是在title标签前面写SELET,比如一个新闻类别的网站,通常在新闻列表页这样写:"",也就是pass带有ID参数的“>”进入“news_detail.asp”页面查看整个新闻信息,所以我们要做的工作都在news_detail.asp页面中。我们也可以使用这种方法来写描述和关键词。当然,这里有一点要提一下,大家请注意,关键词的作用已经微乎其微,如果使用不当,

3、创建静态条目:

在“动静结合,静制动”的原则指导下,我们还可以对网站进行一些修改,尽可能增加动态网页的搜索引擎可见度。例如,如果将动态网页编入静态主页或网站地图中的链接,则动态网页将以静态目录的形式呈现。或者为动态页面建立一个专门的静态入口页面(网关/入口,链接到动态页面),然后将静态入口页面提交给搜索引擎。

以上三点是给大家如何优化动态网站的建议,希望对大家有所帮助!

抓取动态网页( 如何做好动态页面SEO优化?的支持改进方法介绍 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 97 次浏览 • 2022-03-06 20:16

如何做好动态页面SEO优化?的支持改进方法介绍

)

如何优化动态页面

2019-11-28

随着互联网行业的飞速发展,SEO逐渐引起了各企业的关注和关注。企业要想做好SEO优化,首先要详细了解搜索引擎的爬取规则,所以要做好动态页面。优化。相信大家都知道,搜索引擎爬取动态页面是非常困难的。下面就跟着云无羡小编一起来看看如何优化动态页面SEO吧。

建立静态入口:在“动静结合,静制动”的原则指导下,Cloud Infinite团队建议通过对网站进行一些修改,可以使动态网页的搜索引擎可见度尽可能地增加。SEO优化方法是将动态网页编程为静态主页或网站地图中的链接,以静态目录的形式呈现动态网页。或者为动态页面创建一个专门的静态入口页面,链接到动态页面,将静态入口页面提交给搜索引擎。

付费登录搜索引擎:对于带有数据库连接的内容管理系统的动态网站,最直接的SEO优化方法是付费登录。Cloud Unlimited 团队建议将动态网页直接提交到搜索引擎目录,或者做关键字广告以确保网站 被搜索引擎收录 搜索。

搜索引擎支持改进:小编了解到搜索引擎只爬取静态页面链接的动态页面,动态页面链接的动态页面将不再被爬取,也就是说不会爬取动态页面。链接以进行深入访问。但是现在搜索引擎一直在改进对动态页面的支持,以避免搜索机器人的陷阱。

查看全部

抓取动态网页(

如何做好动态页面SEO优化?的支持改进方法介绍

)

如何优化动态页面

2019-11-28

随着互联网行业的飞速发展,SEO逐渐引起了各企业的关注和关注。企业要想做好SEO优化,首先要详细了解搜索引擎的爬取规则,所以要做好动态页面。优化。相信大家都知道,搜索引擎爬取动态页面是非常困难的。下面就跟着云无羡小编一起来看看如何优化动态页面SEO吧。

建立静态入口:在“动静结合,静制动”的原则指导下,Cloud Infinite团队建议通过对网站进行一些修改,可以使动态网页的搜索引擎可见度尽可能地增加。SEO优化方法是将动态网页编程为静态主页或网站地图中的链接,以静态目录的形式呈现动态网页。或者为动态页面创建一个专门的静态入口页面,链接到动态页面,将静态入口页面提交给搜索引擎。

付费登录搜索引擎:对于带有数据库连接的内容管理系统的动态网站,最直接的SEO优化方法是付费登录。Cloud Unlimited 团队建议将动态网页直接提交到搜索引擎目录,或者做关键字广告以确保网站 被搜索引擎收录 搜索。

搜索引擎支持改进:小编了解到搜索引擎只爬取静态页面链接的动态页面,动态页面链接的动态页面将不再被爬取,也就是说不会爬取动态页面。链接以进行深入访问。但是现在搜索引擎一直在改进对动态页面的支持,以避免搜索机器人的陷阱。

抓取动态网页(抓取动态网页有两种思路:如何用api来加载?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 124 次浏览 • 2022-03-04 17:03

抓取动态网页有两种思路:1.formdata,这种代码量少,读取时间比较短;2.api,可以直接调用api,生成一个proto时序图,可以理解其网页生成的过程。具体来说,可以发出url,再发给formdata请求api,如果能生成数据就可以返回。另外,可以通过txt拼接url和分页代码来得到更细的信息。

手机码字,尽量写详细点。

1)高并发同时请求多个url;

2)使用集群高可用;

3)让浏览器实时缓存,

4)请求url的分页。

通过order来看,你可以试试看。

一些定好目的地址吧。也可以用一些爬虫工具(httpwatch)來爬。

分页请求呀。分页抓包改后缀不就行了。

我想应该考虑一下你要爬取的数据是不是有很特殊的行为,如果要抓取但是发现只能抓取某几页的话,那我觉得你还是要考虑一下到底需不需要分页数据。

你可以用urllib2或者phantomjs都可以通过requests进行请求

一般是建议用phantomjs,因为phantomjs加载多页的时候速度有保证。

我看了一下提问人说的页一般是不会下载的,那么我可以猜测他是用这种思路但其实只要能抽象出一个url,而且把下载的链接给了提问人,

利用ie自带的imagejs或者是别的啥flash就可以抓到的一般都是中文的, 查看全部

抓取动态网页(抓取动态网页有两种思路:如何用api来加载?)

抓取动态网页有两种思路:1.formdata,这种代码量少,读取时间比较短;2.api,可以直接调用api,生成一个proto时序图,可以理解其网页生成的过程。具体来说,可以发出url,再发给formdata请求api,如果能生成数据就可以返回。另外,可以通过txt拼接url和分页代码来得到更细的信息。

手机码字,尽量写详细点。

1)高并发同时请求多个url;

2)使用集群高可用;

3)让浏览器实时缓存,

4)请求url的分页。

通过order来看,你可以试试看。

一些定好目的地址吧。也可以用一些爬虫工具(httpwatch)來爬。

分页请求呀。分页抓包改后缀不就行了。

我想应该考虑一下你要爬取的数据是不是有很特殊的行为,如果要抓取但是发现只能抓取某几页的话,那我觉得你还是要考虑一下到底需不需要分页数据。

你可以用urllib2或者phantomjs都可以通过requests进行请求

一般是建议用phantomjs,因为phantomjs加载多页的时候速度有保证。

我看了一下提问人说的页一般是不会下载的,那么我可以猜测他是用这种思路但其实只要能抽象出一个url,而且把下载的链接给了提问人,

利用ie自带的imagejs或者是别的啥flash就可以抓到的一般都是中文的,

抓取动态网页(urllib使用urllib和urllib2的安装配置详解(图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 78 次浏览 • 2022-03-01 21:06

本期文章将与大家分享python如何获取js动态加载数据的内容。小编觉得很有用,所以分享给大家作为参考。跟我一起来看看吧。

我们在进行网页抓取时,一般使用 urllib 和 urllib2 来满足我们的大部分需求。

但是有时我们会遇到使用js动态加载的网页。你会发现 urllib 只能抓取部分空白的网页。就像下面百度图片的结果页面:

查看元素后发现百度图片中,显示图片的div是:pullimages

此 div 内的内容是动态加载的。但是使用 urllib&urllib2 不能爬取。

要抓取动态加载的元素,首先考虑使用 selenium 调用浏览器进行抓取。

而我们的运行环境是linux,最理想的方式是无界面抓取,所以使用selenium+phantomjs进行无界面抓取。

什么是phantomjs?它是一个基于webkit核心的无头浏览器,也就是没有UI界面,就是一个浏览器。

selenium和phantomjs的安装和配置可以google,这里就不多说了。

代码显示如下:

from selenium import webdriver

driver = webdriver.PhantomJS(executable_path='/bin/phantomjs/bin/phantomjs')

#如果不方便配置环境变量。就使用phantomjs的绝对路径也可以

driver.get('http://image.baidu.com/i%3Fie% ... %2339;)

#抓取了百度图片,query:周杰伦

driver.page_source

#这就是返回的页面内容了,与urllib2.urlopen().read()的效果是类似的,但比urllib2强在能抓取到动态渲染后的内容。

driver.quit()

到这里。成功爬取动态页面。

谢谢阅读!这里分享python获取js动态加载数据的方法。希望以上内容可以对大家有所帮助,让大家学习到更多的知识。如果你觉得文章不错,可以分享给更多人看到! 查看全部

抓取动态网页(urllib使用urllib和urllib2的安装配置详解(图))

本期文章将与大家分享python如何获取js动态加载数据的内容。小编觉得很有用,所以分享给大家作为参考。跟我一起来看看吧。

我们在进行网页抓取时,一般使用 urllib 和 urllib2 来满足我们的大部分需求。

但是有时我们会遇到使用js动态加载的网页。你会发现 urllib 只能抓取部分空白的网页。就像下面百度图片的结果页面:

查看元素后发现百度图片中,显示图片的div是:pullimages

此 div 内的内容是动态加载的。但是使用 urllib&urllib2 不能爬取。

要抓取动态加载的元素,首先考虑使用 selenium 调用浏览器进行抓取。

而我们的运行环境是linux,最理想的方式是无界面抓取,所以使用selenium+phantomjs进行无界面抓取。

什么是phantomjs?它是一个基于webkit核心的无头浏览器,也就是没有UI界面,就是一个浏览器。

selenium和phantomjs的安装和配置可以google,这里就不多说了。

代码显示如下:

from selenium import webdriver

driver = webdriver.PhantomJS(executable_path='/bin/phantomjs/bin/phantomjs')

#如果不方便配置环境变量。就使用phantomjs的绝对路径也可以

driver.get('http://image.baidu.com/i%3Fie% ... %2339;)

#抓取了百度图片,query:周杰伦

driver.page_source

#这就是返回的页面内容了,与urllib2.urlopen().read()的效果是类似的,但比urllib2强在能抓取到动态渲染后的内容。

driver.quit()

到这里。成功爬取动态页面。

谢谢阅读!这里分享python获取js动态加载数据的方法。希望以上内容可以对大家有所帮助,让大家学习到更多的知识。如果你觉得文章不错,可以分享给更多人看到!

抓取动态网页( 爬取网页其实就是通过URL获取网页信息的实质是一段添加了JavaScript和CSS的HTML代码)

网站优化 • 优采云 发表了文章 • 0 个评论 • 109 次浏览 • 2022-03-01 21:04

爬取网页其实就是通过URL获取网页信息的实质是一段添加了JavaScript和CSS的HTML代码)

爬取网页实际上是通过 URL 获取网页信息。网页信息的本质是一段添加了 JavaScript 和 CSS 的 HTML 代码。Python 提供了第三方请求模块,用于抓取网页信息。requests 模块自称为“HTTP for Humans”,字面意思是专为人类设计的 HTTP 模块。该模块支持发送请求和获取响应。

1.发送请求

requests 模块提供了许多发送 HTTP 请求的功能。常用的请求函数如表10-1所示。

表 10-1 requests 模块的请求函数

2.得到响应

requests模块提供的Response类对象用于动态响应客户端的请求,控制发送给用户的信息,动态生成响应,包括状态码、网页内容等。接下来用一张表来列出Response类可以获取的信息,如表10-2所示。

表 10-2 Response 类的常用属性

接下来通过一个案例来演示如何使用requests模块爬取百度网页。具体代码如下:

# 01 requests baidu

import requests

base_url = 'http://www.baidu.com'

#发送GET请求

res = requests.get (base_url)

print("响应状态码:{}".format(res.status_code)) #获取响应状态码

print("编码方式:{}".format(res.encoding)) #获取响应内容的编码方式

res.encoding = 'utf-8' #更新响应内容的编码方式为UIE-8

print("网页源代码:\n{}".format(res.text)) #获取响应内容