完整的采集神器

完整的采集神器(想了解php采集神器cURL使用方法详解的相关内容吗)

采集交流 • 优采云 发表了文章 • 0 个评论 • 123 次浏览 • 2022-03-19 13:18

想知道php采集神器cURL使用方法详解的相关内容吗?在本文中,Zjmainstay将为大家讲解php采集神器cURL使用方法详解的相关知识和一些代码示例。欢迎阅读和指正。先说重点:php、采集、cURL,一起来学习吧。

做过data采集的朋友,cURL一定不会陌生。虽然PHP中有一个file_get_contents函数可以获取远程链接的数据,但是它的可控性太差了。对于各种复杂的情况采集,file_get_contents 显得有些力不从心。因此,本文将向您介绍采集神器cURL的使用。

我先给大家补充一下file_get_contents函数是如何获取远程链接数据的。

这段代码会直接使用curl来显示文件的内容,但是问题来了,因为curl是php的扩展,有些主机为了安全会金庸curl,而宁外php在本地调试的时候也会关闭curl,所以一个会发生错误。所以这段代码不可取,所以云洛给他重写了

修改后的版本是对curl扩展做判断,看服务器是否开启了curl扩展。如果打开则直接显示该文件,如果未打开则显示提示文字。

虽然问题已经解决,但还有另一个问题。我只是显示一段文字,并没有用任何东西来做大事,那我为什么要写这么多代码呢??

经过一番废话测试,发现file_get_contents获取远程文件内容并不比curl慢,而且在某些文件较少的情况下可能比curl扩展快很多,于是我又重写了代码

工具

火狐+萤火虫

“要想把工作做好,就必须先利好自己的工具。” 在分析案例之前,我们先学习一下如何使用神器 Firebug 来获取我们需要的信息。

使用F12打开Firebug,我们可以得到如图所示的界面(一):

1、箭头图标是“元素选择”工具。单击一次将突出显示该图标。同时,鼠标在页面中的移动会同时选中HTML菜单中的相应内容。当元素被设置时,图标高亮被取消。如图(二):

Firebug 视图元素

2、控制台

JS中console.log系列函数的打印输出到这里。

3、HTML

HTML内容,注意这里看到的不一定是采集要解析的内容,采集时对内容的分析总是基于查看源码(Ctrl+U ),这里只是为了快速定位元素结构,然后在源码中选择一个专门的引用来定位对应的位置。

例如,如果您在 HTML 中看到一个标签

演示

, 但是你看源码时看到的可能是

演示

,如果按照前者对采集的内容进行正则匹配,则不会得到结果。

4、CSS

这是CSS文件内容

5、脚本

这是Javascript文件内容

6、DOM

dom节点内容

7、网络

每个请求链接的数据,这里是我们采集要重点分析的地方,它可以展示每个请求的参数、请求头、cookie数据等。在页面提交会刷新的情况下,需要使用hold,这样刷新后页面请求内容就保留在控制台中,如图(三):

此外,Firefox还有一个Tamper data扩展,也可以获取请求数据,必要时可以安装使用。

8、Cookie

Cookie 数据

在图中(一),我们也看到下面有很多可选的小菜单项,其中keep是我们要注意的。当它被选中时,即使提交了表单并且页面是刷新后,下方内容区的数据依然会被保留,这对于分析提交的数据尤为关键。

总结

我们在分析采集的请求时,主要关心的是“网络”菜单中的请求数据。如有必要,使用“保持”查看刷新页面的请求数据。在发出请求之前,您可以使用“清除”清除以下内容。

案例分析

一、简单采集

这里所说的简单采集是指单个页面GET请求的采集,简单到即使通过file_get_contents函数也可以轻松获取页面返回结果。

代码片段 file_get_contents

<p> 查看全部

完整的采集神器(想了解php采集神器cURL使用方法详解的相关内容吗)

想知道php采集神器cURL使用方法详解的相关内容吗?在本文中,Zjmainstay将为大家讲解php采集神器cURL使用方法详解的相关知识和一些代码示例。欢迎阅读和指正。先说重点:php、采集、cURL,一起来学习吧。

做过data采集的朋友,cURL一定不会陌生。虽然PHP中有一个file_get_contents函数可以获取远程链接的数据,但是它的可控性太差了。对于各种复杂的情况采集,file_get_contents 显得有些力不从心。因此,本文将向您介绍采集神器cURL的使用。

我先给大家补充一下file_get_contents函数是如何获取远程链接数据的。

这段代码会直接使用curl来显示文件的内容,但是问题来了,因为curl是php的扩展,有些主机为了安全会金庸curl,而宁外php在本地调试的时候也会关闭curl,所以一个会发生错误。所以这段代码不可取,所以云洛给他重写了

修改后的版本是对curl扩展做判断,看服务器是否开启了curl扩展。如果打开则直接显示该文件,如果未打开则显示提示文字。

虽然问题已经解决,但还有另一个问题。我只是显示一段文字,并没有用任何东西来做大事,那我为什么要写这么多代码呢??

经过一番废话测试,发现file_get_contents获取远程文件内容并不比curl慢,而且在某些文件较少的情况下可能比curl扩展快很多,于是我又重写了代码

工具

火狐+萤火虫

“要想把工作做好,就必须先利好自己的工具。” 在分析案例之前,我们先学习一下如何使用神器 Firebug 来获取我们需要的信息。

使用F12打开Firebug,我们可以得到如图所示的界面(一):

1、箭头图标是“元素选择”工具。单击一次将突出显示该图标。同时,鼠标在页面中的移动会同时选中HTML菜单中的相应内容。当元素被设置时,图标高亮被取消。如图(二):

Firebug 视图元素

2、控制台

JS中console.log系列函数的打印输出到这里。

3、HTML

HTML内容,注意这里看到的不一定是采集要解析的内容,采集时对内容的分析总是基于查看源码(Ctrl+U ),这里只是为了快速定位元素结构,然后在源码中选择一个专门的引用来定位对应的位置。

例如,如果您在 HTML 中看到一个标签

演示

, 但是你看源码时看到的可能是

演示

,如果按照前者对采集的内容进行正则匹配,则不会得到结果。

4、CSS

这是CSS文件内容

5、脚本

这是Javascript文件内容

6、DOM

dom节点内容

7、网络

每个请求链接的数据,这里是我们采集要重点分析的地方,它可以展示每个请求的参数、请求头、cookie数据等。在页面提交会刷新的情况下,需要使用hold,这样刷新后页面请求内容就保留在控制台中,如图(三):

此外,Firefox还有一个Tamper data扩展,也可以获取请求数据,必要时可以安装使用。

8、Cookie

Cookie 数据

在图中(一),我们也看到下面有很多可选的小菜单项,其中keep是我们要注意的。当它被选中时,即使提交了表单并且页面是刷新后,下方内容区的数据依然会被保留,这对于分析提交的数据尤为关键。

总结

我们在分析采集的请求时,主要关心的是“网络”菜单中的请求数据。如有必要,使用“保持”查看刷新页面的请求数据。在发出请求之前,您可以使用“清除”清除以下内容。

案例分析

一、简单采集

这里所说的简单采集是指单个页面GET请求的采集,简单到即使通过file_get_contents函数也可以轻松获取页面返回结果。

代码片段 file_get_contents

<p>

完整的采集神器(完整的采集数据格式是如何的呢?分享一下)

采集交流 • 优采云 发表了文章 • 0 个评论 • 112 次浏览 • 2022-03-17 15:01

完整的采集神器是可以以实时数据作为参考采集高质量数据的,so,你的采集数据格式是如何的呢?分享一下,仅供参考,能够采集高质量数据的软件,

请使用采访工具,而非模版,比如知乎大v采访的模版可能需要你提供一份高质量的问卷调查问卷,

更新,那几个图,是可以爬,但不想爬。什么样的图才是爬虫爬不到的。

别人随便扯几句,

模版的话代码上好办,

图1这样的:题目是“人工智能是否等同于‘热工程’?”,底下是各种附带图片的文字。有目的的有针对性地采集“热工程”这几个字(包括附带图片文字)应该可以看到很多,不过附带图片文字只是相对比较难找,需要一定的专业经验。采集问题是通过阿里云spark生产环境采集。不过,还是发现了好多问题不是很清楚怎么做爬虫,太多数据抓不到不能归总:有的抓了很多问题没有用上一般模版,有的数据太多用了很多没有用到模版,有的数据多做了一个小按钮数据抓不到;有的采集完不能直接在阿里云做spark应用程序运行,有的不能运行算法而在本地跑,有的没有做归类,有的不能自定义插入一些字段等等。回过头来发现阿里云不提供爬虫服务,也有爬虫版本,抓取速度也不快。想再采集几十个数据点真的很难。 查看全部

完整的采集神器(完整的采集数据格式是如何的呢?分享一下)

完整的采集神器是可以以实时数据作为参考采集高质量数据的,so,你的采集数据格式是如何的呢?分享一下,仅供参考,能够采集高质量数据的软件,

请使用采访工具,而非模版,比如知乎大v采访的模版可能需要你提供一份高质量的问卷调查问卷,

更新,那几个图,是可以爬,但不想爬。什么样的图才是爬虫爬不到的。

别人随便扯几句,

模版的话代码上好办,

图1这样的:题目是“人工智能是否等同于‘热工程’?”,底下是各种附带图片的文字。有目的的有针对性地采集“热工程”这几个字(包括附带图片文字)应该可以看到很多,不过附带图片文字只是相对比较难找,需要一定的专业经验。采集问题是通过阿里云spark生产环境采集。不过,还是发现了好多问题不是很清楚怎么做爬虫,太多数据抓不到不能归总:有的抓了很多问题没有用上一般模版,有的数据太多用了很多没有用到模版,有的数据多做了一个小按钮数据抓不到;有的采集完不能直接在阿里云做spark应用程序运行,有的不能运行算法而在本地跑,有的没有做归类,有的不能自定义插入一些字段等等。回过头来发现阿里云不提供爬虫服务,也有爬虫版本,抓取速度也不快。想再采集几十个数据点真的很难。

完整的采集神器(PHP中有file_get_contents函数可以获取远程链接数据)

采集交流 • 优采云 发表了文章 • 0 个评论 • 76 次浏览 • 2022-03-02 02:14

做过data采集的朋友,cURL一定不会陌生。虽然PHP中有一个file_get_contents函数可以获取远程链接的数据,但是它的可控性太差了。对于各种复杂的情况采集,file_get_contents 显得有些力不从心。因此,本文将向您介绍采集神器cURL的使用。

我先给大家补充一下file_get_contents函数是如何获取远程链接数据的。

这段代码会直接使用curl来显示文件的内容,但是问题来了,因为curl是php的扩展,有些主机为了安全会金庸curl,而宁外php在本地调试的时候也会关闭curl,所以一个会发生错误。所以这段代码不可取,所以云洛给他重写了

修改后的版本是对curl扩展做判断,看服务器是否开启了curl扩展。如果打开则直接显示该文件,如果未打开则显示提示文字。虽然问题已经解决,但还有另一个问题。我只是显示一段文字,并没有用任何东西来做大事,那我为什么要写这么多代码呢?? 经过一番废话测试,发现file_get_contents获取远程文件内容并不比curl慢,而且在某些文件较少的情况下可能比curl扩展快很多,于是我又重写了代码

工具 Firefox (FireFox) + Firebug “如果你想做好,你必须先磨砺你的工具。” 在分析案例之前,我们先学习一下如何使用神器 Firebug 来获取我们需要的信息。使用F12打开Firebug,我们可以得到如图所示的界面(一):

1、箭头图标是“元素选择”工具。单击一次将突出显示该图标。同时,鼠标在页面中的移动会同时选中HTML菜单中的相应内容。当元素被设置时,图标高亮被取消。如图(二):Firebug 视图元素

2、控制台JS中console.log系列函数的打印输出到这里。3、HTMLHTML内容,注意这里看到的不一定是采集要解析的内容,采集时对内容的分析总是基于查看源码(Ctrl +U),这里只是可以快速定位元素的结构,然后在源码中选择一个特殊的引用来定位对应的位置。例如,如果您在 HTML 中看到一个标签

演示

, 但是你看源码时看到的可能是

演示

,如果按照前者对采集的内容进行正则匹配,则不会得到结果。4、CSS这里是CSS文件内容5、Script这里是Javascript文件内容6、DOMDom节点内容7、网络中各个请求链接的数据,这里是我们的采集 重点分析哪里,可以显示每个请求的参数、请求头、cookie数据等。在页面提交会刷新的情况下,需要使用hold,这样刷新后页面请求内容会保留在控制台中,如图(三):

此外,Firefox还有一个Tamper data扩展,也可以获取请求数据,必要时可以安装使用。8、CookiesCookie 数据

在图中(一),我们也看到下面有很多可选的小菜单项,其中keep是我们要注意的。当它被选中时,即使提交了表单并且页面是刷新后,下方内容区的数据依然会被保留,这对于分析提交的数据尤为关键。

总结 我们在分析采集的请求时,主要关心的是“网络”菜单中的请求数据。如有必要,使用“保持”查看刷新页面的请求数据。在发出请求之前,您可以使用“清除”清除以下内容。

案例分析一、Simple采集Simple采集这里指的是单页GET请求采集,简单到即使通过file_get_contents函数也能轻松获取页面返回结果。

代码片段 file_get_contents

<p> 查看全部

完整的采集神器(PHP中有file_get_contents函数可以获取远程链接数据)

做过data采集的朋友,cURL一定不会陌生。虽然PHP中有一个file_get_contents函数可以获取远程链接的数据,但是它的可控性太差了。对于各种复杂的情况采集,file_get_contents 显得有些力不从心。因此,本文将向您介绍采集神器cURL的使用。

我先给大家补充一下file_get_contents函数是如何获取远程链接数据的。

这段代码会直接使用curl来显示文件的内容,但是问题来了,因为curl是php的扩展,有些主机为了安全会金庸curl,而宁外php在本地调试的时候也会关闭curl,所以一个会发生错误。所以这段代码不可取,所以云洛给他重写了

修改后的版本是对curl扩展做判断,看服务器是否开启了curl扩展。如果打开则直接显示该文件,如果未打开则显示提示文字。虽然问题已经解决,但还有另一个问题。我只是显示一段文字,并没有用任何东西来做大事,那我为什么要写这么多代码呢?? 经过一番废话测试,发现file_get_contents获取远程文件内容并不比curl慢,而且在某些文件较少的情况下可能比curl扩展快很多,于是我又重写了代码

工具 Firefox (FireFox) + Firebug “如果你想做好,你必须先磨砺你的工具。” 在分析案例之前,我们先学习一下如何使用神器 Firebug 来获取我们需要的信息。使用F12打开Firebug,我们可以得到如图所示的界面(一):

1、箭头图标是“元素选择”工具。单击一次将突出显示该图标。同时,鼠标在页面中的移动会同时选中HTML菜单中的相应内容。当元素被设置时,图标高亮被取消。如图(二):Firebug 视图元素

2、控制台JS中console.log系列函数的打印输出到这里。3、HTMLHTML内容,注意这里看到的不一定是采集要解析的内容,采集时对内容的分析总是基于查看源码(Ctrl +U),这里只是可以快速定位元素的结构,然后在源码中选择一个特殊的引用来定位对应的位置。例如,如果您在 HTML 中看到一个标签

演示

, 但是你看源码时看到的可能是

演示

,如果按照前者对采集的内容进行正则匹配,则不会得到结果。4、CSS这里是CSS文件内容5、Script这里是Javascript文件内容6、DOMDom节点内容7、网络中各个请求链接的数据,这里是我们的采集 重点分析哪里,可以显示每个请求的参数、请求头、cookie数据等。在页面提交会刷新的情况下,需要使用hold,这样刷新后页面请求内容会保留在控制台中,如图(三):

此外,Firefox还有一个Tamper data扩展,也可以获取请求数据,必要时可以安装使用。8、CookiesCookie 数据

在图中(一),我们也看到下面有很多可选的小菜单项,其中keep是我们要注意的。当它被选中时,即使提交了表单并且页面是刷新后,下方内容区的数据依然会被保留,这对于分析提交的数据尤为关键。

总结 我们在分析采集的请求时,主要关心的是“网络”菜单中的请求数据。如有必要,使用“保持”查看刷新页面的请求数据。在发出请求之前,您可以使用“清除”清除以下内容。

案例分析一、Simple采集Simple采集这里指的是单页GET请求采集,简单到即使通过file_get_contents函数也能轻松获取页面返回结果。

代码片段 file_get_contents

<p>

完整的采集神器(Python进阶资料和高级开发教程,欢迎进阶中和进想深入Python的小伙伴!)

采集交流 • 优采云 发表了文章 • 0 个评论 • 125 次浏览 • 2022-02-28 11:04

python 采集网站数据,本教程使用scrapy spider

1、安装 Scrapy 框架

命令行执行:

pip install scrapy

如果安装的scrapy依赖包与你之前安装的其他python包冲突,建议使用Virtualenv安装

安装完成后,随便找个文件夹创建爬虫

scrapy startproject 你的蜘蛛名称

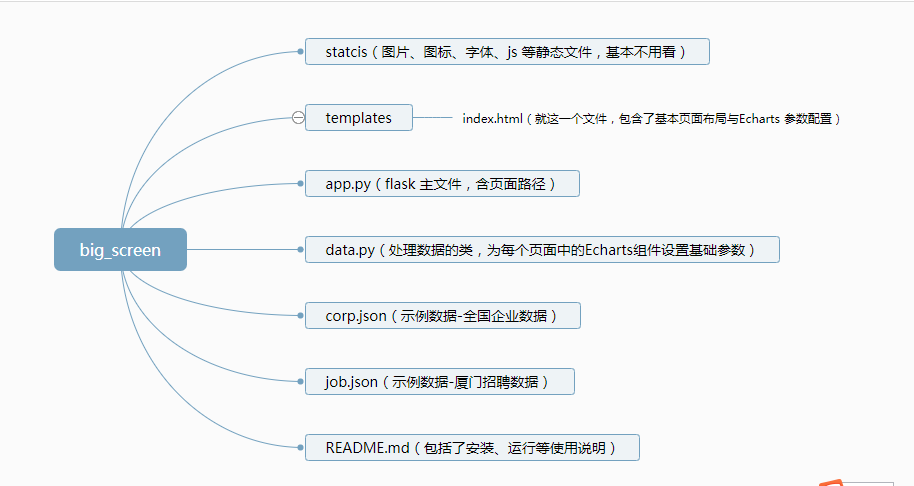

文件夹目录

/imgrdrct/https://img-blog.csdnimg.cn/20 ... rmark,type_ZmFuZ3poZW5naGVpdGk,shadow_10,text_aHR0cHM6Ly9ibG9nLmNzZG4ubmV0L3dlaXhpbl80NjczNzc1NQ==,size_16,color_FFFFFF,t_70

爬虫规则写在spiders目录中

items.py - 要抓取的数据

pipelines.py - 执行数据保存

设置 - 配置

middlewares.py—下载器

以下是采集小说网站

的源码

首先在items.py中定义采集的数据

# author 小白

import scrapy

class BookspiderItem(scrapy.Item):

# define the fields for your item here like:

i = scrapy.Field()

book_name = scrapy.Field()

book_img = scrapy.Field()

book_author = scrapy.Field()

book_last_chapter = scrapy.Field()

book_last_time = scrapy.Field()

book_list_name = scrapy.Field()

book_content = scrapy.Field()

pass

编写采集规则

保存数据

import os

class BookspiderPipeline(object):

def process_item(self, item, spider):

curPath = 'E:/小说/'

tempPath = str(item['book_name'])

targetPath = curPath + tempPath

if not os.path.exists(targetPath):

os.makedirs(targetPath)

book_list_name = str(str(item['i'])+item['book_list_name'])

filename_path = targetPath+'/'+book_list_name+'.txt'

print('------------')

print(filename_path)

with open(filename_path,'a',encoding='utf-8') as f:

f.write(item['book_content'])

return item

执行

scrapy crawl BookSpider

采集

完成一个新颖的程序

在这里推荐

scrapy shell 爬取的网页url

然后 response.css('') 测试规则是否正确

推荐我自己建的Python开发学习群:810735403,群都是通过学习Python开发的。如果您正在学习 Python,欢迎您加入。大家都是软件开发党,时不时分享干货。 (仅与Python软件开发相关),包括我自己编译的2020年最新Python进阶资料和进阶开发教程的副本。欢迎有志于深入 Python 的进阶伙伴! 查看全部

完整的采集神器(Python进阶资料和高级开发教程,欢迎进阶中和进想深入Python的小伙伴!)

python 采集网站数据,本教程使用scrapy spider

1、安装 Scrapy 框架

命令行执行:

pip install scrapy

如果安装的scrapy依赖包与你之前安装的其他python包冲突,建议使用Virtualenv安装

安装完成后,随便找个文件夹创建爬虫

scrapy startproject 你的蜘蛛名称

文件夹目录

/imgrdrct/https://img-blog.csdnimg.cn/20 ... rmark,type_ZmFuZ3poZW5naGVpdGk,shadow_10,text_aHR0cHM6Ly9ibG9nLmNzZG4ubmV0L3dlaXhpbl80NjczNzc1NQ==,size_16,color_FFFFFF,t_70

爬虫规则写在spiders目录中

items.py - 要抓取的数据

pipelines.py - 执行数据保存

设置 - 配置

middlewares.py—下载器

以下是采集小说网站

的源码

首先在items.py中定义采集的数据

# author 小白

import scrapy

class BookspiderItem(scrapy.Item):

# define the fields for your item here like:

i = scrapy.Field()

book_name = scrapy.Field()

book_img = scrapy.Field()

book_author = scrapy.Field()

book_last_chapter = scrapy.Field()

book_last_time = scrapy.Field()

book_list_name = scrapy.Field()

book_content = scrapy.Field()

pass

编写采集规则

保存数据

import os

class BookspiderPipeline(object):

def process_item(self, item, spider):

curPath = 'E:/小说/'

tempPath = str(item['book_name'])

targetPath = curPath + tempPath

if not os.path.exists(targetPath):

os.makedirs(targetPath)

book_list_name = str(str(item['i'])+item['book_list_name'])

filename_path = targetPath+'/'+book_list_name+'.txt'

print('------------')

print(filename_path)

with open(filename_path,'a',encoding='utf-8') as f:

f.write(item['book_content'])

return item

执行

scrapy crawl BookSpider

采集

完成一个新颖的程序

在这里推荐

scrapy shell 爬取的网页url

然后 response.css('') 测试规则是否正确

推荐我自己建的Python开发学习群:810735403,群都是通过学习Python开发的。如果您正在学习 Python,欢迎您加入。大家都是软件开发党,时不时分享干货。 (仅与Python软件开发相关),包括我自己编译的2020年最新Python进阶资料和进阶开发教程的副本。欢迎有志于深入 Python 的进阶伙伴!

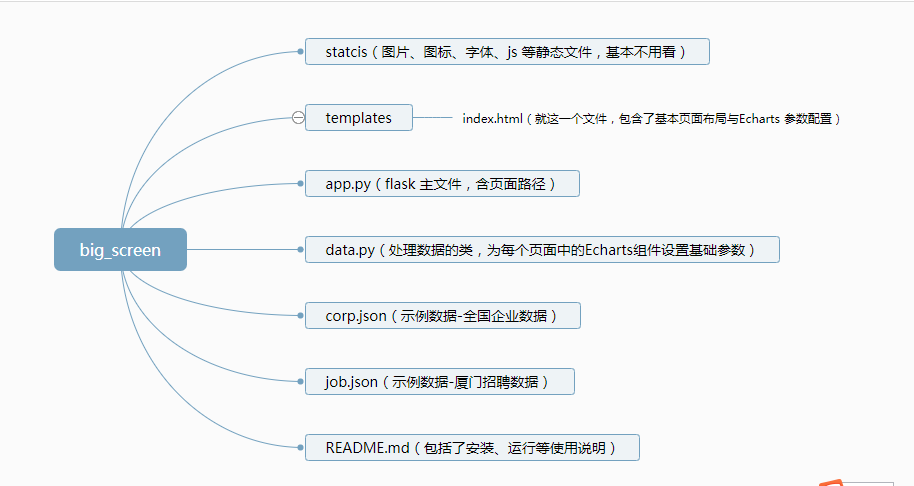

完整的采集神器(大数据可视化通用模板项目使用说明总结(一)|废话不说 )

采集交流 • 优采云 发表了文章 • 0 个评论 • 136 次浏览 • 2022-02-23 21:18

)

废话不多说,先上传动画吧,有点大,请耐心等待

大数据可视化展板通用模板项目介绍

项目基本结构

项目基本结构安装创建虚拟环境,安装Flask运行项目及使用总结

虽然这个项目的效果很惊艳,但是实现起来还是比较简单的。只要掌握一些flask、html、echarts的基础知识,就可以定制属于自己的数据可视化大屏,提升自己在老板心中的价值,是不是很棒呢?香

扫码免费获取10000个代理IP,高并发不限,稳定速度快,去毛线!

精选文章系列视频|Python网络爬虫与文本数据分析B站视频 | Python自动化办公

SciencePlots | 科研样式绘图库使用streamlit上线中文文本分析网站

bsite库 | 采集B站视频信息、评论数据

texthero包 | 支持dataframe的文本分析包爬虫实战 | 采集&可视化知乎问题的回答reticulate包 | 在Rmarkdown中调用Python代码plydata库 | 数据操作管道操作符>>plotnine: Python版的ggplot2作图库读完本文你就了解什么是文本分析

文本分析在经管领域中的应用概述 综述:文本分析在市场营销研究中的应用

plotnine: Python版的ggplot2作图库Wow~70G上市公司定期报告数据集

漂亮~pandas可以无缝衔接Bokeh YelpDaset: 酒店管理类数据集10+G 查看全部

完整的采集神器(大数据可视化通用模板项目使用说明总结(一)|废话不说

)

废话不多说,先上传动画吧,有点大,请耐心等待

大数据可视化展板通用模板项目介绍

项目基本结构

项目基本结构安装创建虚拟环境,安装Flask运行项目及使用总结

虽然这个项目的效果很惊艳,但是实现起来还是比较简单的。只要掌握一些flask、html、echarts的基础知识,就可以定制属于自己的数据可视化大屏,提升自己在老板心中的价值,是不是很棒呢?香

扫码免费获取10000个代理IP,高并发不限,稳定速度快,去毛线!

精选文章系列视频|Python网络爬虫与文本数据分析B站视频 | Python自动化办公

SciencePlots | 科研样式绘图库使用streamlit上线中文文本分析网站

bsite库 | 采集B站视频信息、评论数据

texthero包 | 支持dataframe的文本分析包爬虫实战 | 采集&可视化知乎问题的回答reticulate包 | 在Rmarkdown中调用Python代码plydata库 | 数据操作管道操作符>>plotnine: Python版的ggplot2作图库读完本文你就了解什么是文本分析

文本分析在经管领域中的应用概述 综述:文本分析在市场营销研究中的应用

plotnine: Python版的ggplot2作图库Wow~70G上市公司定期报告数据集

漂亮~pandas可以无缝衔接Bokeh YelpDaset: 酒店管理类数据集10+G

完整的采集神器(先给file_get_contents函数可以获取远程链接数据的方法)

采集交流 • 优采云 发表了文章 • 0 个评论 • 165 次浏览 • 2022-02-18 05:23

做过data采集的朋友,curl一定不会陌生。虽然php中有file_get_contents函数可以获取远程链接的数据,但是可控性太差。对于各种复杂的情况采集,file_get_contents 显得有些力不从心。因此,本文将向您介绍采集神器curl的使用。

我先给大家补充一下file_get_contents函数是如何获取远程链接数据的。

这段代码会直接使用curl来显示文件内容,但是问题来了,因为curl是php的扩展,有些主机为了安全会金庸curl,而宁外php在本地调试的时候也会关闭curl,所以会报错发生。所以这段代码不可取,所以云洛给他重写了

修改后的版本是对curl扩展做判断,看服务器是否开启了curl扩展。如果打开则直接显示该文件,如果未打开则显示提示文字。

虽然问题已经解决,但还有另一个问题。我只是显示一段文字,并没有用任何东西来做大事,那我为什么要写这么多代码呢??

经过一番废话测试,发现file_get_contents获取远程文件内容并不比curl慢,而且在某些文件较少的情况下可能比curl扩展快很多,于是我又重写了代码

工具

火狐+萤火虫

“要想把工作做好,就必须先利好自己的工具。” 在分析案例之前,让我们学习一下如何使用神器firebug来获取我们需要的信息。

使用f12打开firebug,我们可以得到如图所示的界面(一):

1、箭头图标是“元素选择”工具。单击一次将突出显示该图标。同时,鼠标在页面中的移动会同时选中html菜单中的相应内容。当元素被设置时,图标高亮被取消。如图(二):

萤火虫视图元素

2、控制台

js中console.log系列函数的打印输出到这里。

3、html

html内容,注意这里看到的不一定是采集要解析的内容。采集 的时候对内容的分析总是基于查看源码(ctrl+u),也就是快速定位元素。结构,然后选择一个特殊的引用来定位源代码中的对应位置。

例如,您在 html 中看到一个标签,即

演示

, 但是你看源码时看到的可能是

演示

,如果按照前者对采集的内容进行正则匹配,则不会得到结果。

4、css

这是css文件内容

5、脚本

这是javascript文件内容

6、dom

dom节点内容

7、网络

每个请求链接的数据,这里是我们采集要重点分析的地方,它可以展示每个请求的参数、请求头、cookie数据等。在页面提交会刷新的情况下,需要使用hold,这样刷新后页面请求内容就保留在控制台中,如图(三):

此外,火狐还有一个篡改数据扩展,同样可以获取请求数据,必要时可以安装使用。

8、cookies

饼干数据

在图中(一),我们也看到下面有很多可选的小菜单项,其中keep是我们要注意的。当它被选中时,即使提交了表单并且页面是刷新后,下方内容区的数据依然会被保留,这对于分析提交的数据尤为关键。

总结

我们在分析采集的请求时,主要关心的是“网络”菜单中的请求数据。如有必要,使用“保持”查看刷新页面的请求数据。在发出请求之前,您可以使用“清除”清除以下内容。

案例分析

一、简单采集

这里所说的简单采集是指单个页面get请求的采集,简单到即使通过file_get_contents函数也可以轻松获取页面返回结果。

代码片段 file_get_contents

<p> 查看全部

完整的采集神器(先给file_get_contents函数可以获取远程链接数据的方法)

做过data采集的朋友,curl一定不会陌生。虽然php中有file_get_contents函数可以获取远程链接的数据,但是可控性太差。对于各种复杂的情况采集,file_get_contents 显得有些力不从心。因此,本文将向您介绍采集神器curl的使用。

我先给大家补充一下file_get_contents函数是如何获取远程链接数据的。

这段代码会直接使用curl来显示文件内容,但是问题来了,因为curl是php的扩展,有些主机为了安全会金庸curl,而宁外php在本地调试的时候也会关闭curl,所以会报错发生。所以这段代码不可取,所以云洛给他重写了

修改后的版本是对curl扩展做判断,看服务器是否开启了curl扩展。如果打开则直接显示该文件,如果未打开则显示提示文字。

虽然问题已经解决,但还有另一个问题。我只是显示一段文字,并没有用任何东西来做大事,那我为什么要写这么多代码呢??

经过一番废话测试,发现file_get_contents获取远程文件内容并不比curl慢,而且在某些文件较少的情况下可能比curl扩展快很多,于是我又重写了代码

工具

火狐+萤火虫

“要想把工作做好,就必须先利好自己的工具。” 在分析案例之前,让我们学习一下如何使用神器firebug来获取我们需要的信息。

使用f12打开firebug,我们可以得到如图所示的界面(一):

1、箭头图标是“元素选择”工具。单击一次将突出显示该图标。同时,鼠标在页面中的移动会同时选中html菜单中的相应内容。当元素被设置时,图标高亮被取消。如图(二):

萤火虫视图元素

2、控制台

js中console.log系列函数的打印输出到这里。

3、html

html内容,注意这里看到的不一定是采集要解析的内容。采集 的时候对内容的分析总是基于查看源码(ctrl+u),也就是快速定位元素。结构,然后选择一个特殊的引用来定位源代码中的对应位置。

例如,您在 html 中看到一个标签,即

演示

, 但是你看源码时看到的可能是

演示

,如果按照前者对采集的内容进行正则匹配,则不会得到结果。

4、css

这是css文件内容

5、脚本

这是javascript文件内容

6、dom

dom节点内容

7、网络

每个请求链接的数据,这里是我们采集要重点分析的地方,它可以展示每个请求的参数、请求头、cookie数据等。在页面提交会刷新的情况下,需要使用hold,这样刷新后页面请求内容就保留在控制台中,如图(三):

此外,火狐还有一个篡改数据扩展,同样可以获取请求数据,必要时可以安装使用。

8、cookies

饼干数据

在图中(一),我们也看到下面有很多可选的小菜单项,其中keep是我们要注意的。当它被选中时,即使提交了表单并且页面是刷新后,下方内容区的数据依然会被保留,这对于分析提交的数据尤为关键。

总结

我们在分析采集的请求时,主要关心的是“网络”菜单中的请求数据。如有必要,使用“保持”查看刷新页面的请求数据。在发出请求之前,您可以使用“清除”清除以下内容。

案例分析

一、简单采集

这里所说的简单采集是指单个页面get请求的采集,简单到即使通过file_get_contents函数也可以轻松获取页面返回结果。

代码片段 file_get_contents

<p>

完整的采集神器(两个和Logsene的监控与日志工具对比(组图))

采集交流 • 优采云 发表了文章 • 0 个评论 • 157 次浏览 • 2022-02-16 12:14

Rancher 社区维护的应用商店最近迎来了两个明星项目——SPM 和来自 Sematext 的监控和日志工具 Logsene。如果您已经熟悉 Logstash、Kibana、Prometheus、Grafana 等监控或日志解决方案,那么请仔细阅读这篇文章,它将向您展示 SPM 和 Logsene 为 Rancher 用户带来了哪些功能,以及其他解决方案有哪些不同之处。

联系Sematext Docker AgentSematext Docker Agent是目前Docker原生监控和日志采集Agent程序。它在每个 Docker 主机上运行一个非常小的容器来采集所有集群节点和这些节点上的容器的日志、系统指标和事件。Agent 代理监控 Rancher 管理的所有节点。部署 Sematext Docker Agent 后,所有日志、Docker 事件、各种指标都可以对外访问。

这将变得有价值,为什么?因为这意味着您不再需要花费数小时甚至数天的时间来弄清楚 采集 您需要什么数据或如何绘制它。另外,你不需要花费资源来维护自己的日志监控系统,你的Docker系统指标和事件会输出到SPM,日志会输出到Logsene(SPM是一个应用性能监控服务,支持Integration,当然还包括 Docker,而 Logsene 是一个日志管理服务,一个托管在 Rancher 中的 ELK 应用程序堆栈,可以很好地与 Kibana 和 Grafana 配合使用)

DevOps 工具对比 Docker 日志和指标处理的一些开源工具供我们选择,例如 cAdvisor 和 Logspout。不幸的是,这些工具都不够全面。一种解决方案是集成一系列工具来实现目标,但这样做的后果是使系统朝着“Franken-monitoring”的方向发展(指的是技术的大杂烩,每个组件都没有按承诺发挥作用) ",因此用户将受到影响。由于沉重的技术债务,没有人愿意解决如此复杂的故障。

因此,另一个解决方案是像 Sematext Docker Agent 这样的工具,它只是结合了 cAdvisor 和 Logspout,其功能特别侧重于日志管理,例如格式检查、日志解析、数据改进(Geo-IP 地址地理定位信息)、元数据标签等)和日志路由。

通过 Rancher 目录配置 Sematext Docker 代理 要在 Rancher 平台上设置 Sematext Docker 代理,您只需选择适当的目录模板(在 Rancher 社区目录条目下查找“Sematext”)。让我们快速了解一下 Sematex 提供哪些功能?如何在 Rancher 平台上进行设置?

Docker Compose 和 Kubernetes 自动日志标签

所有日志都标有元数据,其中包括对 Docker/Rancher Compose 项目和 Kubernetes 的支持:

对于 Docker 容器

为 Docker/Rancher 编写

对于 Kubernetes

请注意,Kubernetes 容器的日志与其他 Docker 容器的日志没有太大区别,但是 Kubernetes 用户需要访问已部署 pod 的日志,因此抓取 Kubernetes 特定信息以进行日志搜索非常有用,例如:

提示:要启用 Kubernetes 标签,设置 Kubernetes=1 日志路由对于较大的部署,您可能需要为不同的租户或应用程序索引日志,将它们输出到不同的路径或 Logsene 应用程序处理(这样您也可以区分不同用户的访问权限到不同的日志)。

我们让这变得非常简单:只需将 Docker 标记添加到您的容器,或设置 LOGSENE_TOKEN 环境变量(LOGSENE_TOKEN=您的应用程序令牌),Sematext Docker 代理就会将日志发送到正确的索引条目!这样,您根本不需要中央配置文件来映射容器和索引项目/令牌,因此日志路由变得非常灵活、动态和弹性。

Integrated Log Parser 日志处理基于 Docker API 和一个名为 logagent-js 的库,该库由 Sematext 开源。该分析框架包括用于日志格式检测和分析标准正式 Docker 容器使用的不同日志格式的模式:

提示:如果您想创建自定义模式,请将它们添加到 Rancher 目录模板中名为 LOGAGENT_PATTERNS 的字段中。自动容器日志记录 Geo-IP 增强功能 从 Docker 容器外部获取日志到 采集 运输和分析节省了大量时间,但一些应用程序日志需要其他数据源的额外增强功能。一种常见的情况是增强Web Server的日志信息(或任何收录IP地址信息的日志),并为日志中的IP地址提供其地理位置信息。

Sematext Docker Agent 支持 docker 日志的 Geo-IP 丰富。它使用 Maxmind Geo-IP 轻量级数据库,为您提供定期更新的信息,而无需停止容器或为其挂载收录 Geo-IP 数据库的新卷,或任何其他手动操作。

提示:要启用 Geo-IP 增强功能,请设置环境变量 GEOIP_ENABLED=true。过滤容器日志 在某些情况下,我们只需要采集重要应用程序的日志,而忽略低优先级或嘈杂的服务日志(例如那些经常清理的日志)。这样,我们可以使用白名单或黑名单(容器名称或镜像名称)来处理这些容器,其设置使用正则表达式匹配对应的元数据字段。

如何使用 Sematext Catalog 项目 在 Rancher 的 UI 中,进入社区的 Catalog 项目列表,搜索关键字“sematext”、“monitoring”或“logs”。

点击“查看详情”,在“配置选项”选项中输入SPM和Logsene App的token。从这里您可以注册和创建您的 SPM 和 Logsene 应用程序,然后获取这些访问令牌。如果您的 Rancher 集群在防火墙(代理)后面运行,您需要在 HTTPS_PROXY 或 HTTP_PROXY 环境变量中填写代理 URL。如果您还在此集群中运行 Kubernetes,请选择 KUBERNETES=1。

如果要采集所有日志,容器或镜像名称不要填写任何过滤值,只需点击“启动”即可。

结束语 我们希望这篇对 Rancher 平台中 Sematext Docker Agent 的介绍可以帮助您开始监控和记录 Docker,而不必担心繁琐模式的大杂烩。本项目完整的配置参数可以参考参考。我们相信新的目录模板已经涵盖了最常见的选项。如果您发现缺少一些重要的项目,请将它们提交到 Rancher 社区目录(提交问题或拉取请求)。尝试使用 Rancher 的 Sematext Docker Agent,所有服务将被轻松接管,您将高枕无忧。Rancher 社区目录让日志监控系统在瞬间启动和运行变得非常容易。 查看全部

完整的采集神器(两个和Logsene的监控与日志工具对比(组图))

Rancher 社区维护的应用商店最近迎来了两个明星项目——SPM 和来自 Sematext 的监控和日志工具 Logsene。如果您已经熟悉 Logstash、Kibana、Prometheus、Grafana 等监控或日志解决方案,那么请仔细阅读这篇文章,它将向您展示 SPM 和 Logsene 为 Rancher 用户带来了哪些功能,以及其他解决方案有哪些不同之处。

联系Sematext Docker AgentSematext Docker Agent是目前Docker原生监控和日志采集Agent程序。它在每个 Docker 主机上运行一个非常小的容器来采集所有集群节点和这些节点上的容器的日志、系统指标和事件。Agent 代理监控 Rancher 管理的所有节点。部署 Sematext Docker Agent 后,所有日志、Docker 事件、各种指标都可以对外访问。

这将变得有价值,为什么?因为这意味着您不再需要花费数小时甚至数天的时间来弄清楚 采集 您需要什么数据或如何绘制它。另外,你不需要花费资源来维护自己的日志监控系统,你的Docker系统指标和事件会输出到SPM,日志会输出到Logsene(SPM是一个应用性能监控服务,支持Integration,当然还包括 Docker,而 Logsene 是一个日志管理服务,一个托管在 Rancher 中的 ELK 应用程序堆栈,可以很好地与 Kibana 和 Grafana 配合使用)

DevOps 工具对比 Docker 日志和指标处理的一些开源工具供我们选择,例如 cAdvisor 和 Logspout。不幸的是,这些工具都不够全面。一种解决方案是集成一系列工具来实现目标,但这样做的后果是使系统朝着“Franken-monitoring”的方向发展(指的是技术的大杂烩,每个组件都没有按承诺发挥作用) ",因此用户将受到影响。由于沉重的技术债务,没有人愿意解决如此复杂的故障。

因此,另一个解决方案是像 Sematext Docker Agent 这样的工具,它只是结合了 cAdvisor 和 Logspout,其功能特别侧重于日志管理,例如格式检查、日志解析、数据改进(Geo-IP 地址地理定位信息)、元数据标签等)和日志路由。

通过 Rancher 目录配置 Sematext Docker 代理 要在 Rancher 平台上设置 Sematext Docker 代理,您只需选择适当的目录模板(在 Rancher 社区目录条目下查找“Sematext”)。让我们快速了解一下 Sematex 提供哪些功能?如何在 Rancher 平台上进行设置?

Docker Compose 和 Kubernetes 自动日志标签

所有日志都标有元数据,其中包括对 Docker/Rancher Compose 项目和 Kubernetes 的支持:

对于 Docker 容器

为 Docker/Rancher 编写

对于 Kubernetes

请注意,Kubernetes 容器的日志与其他 Docker 容器的日志没有太大区别,但是 Kubernetes 用户需要访问已部署 pod 的日志,因此抓取 Kubernetes 特定信息以进行日志搜索非常有用,例如:

提示:要启用 Kubernetes 标签,设置 Kubernetes=1 日志路由对于较大的部署,您可能需要为不同的租户或应用程序索引日志,将它们输出到不同的路径或 Logsene 应用程序处理(这样您也可以区分不同用户的访问权限到不同的日志)。

我们让这变得非常简单:只需将 Docker 标记添加到您的容器,或设置 LOGSENE_TOKEN 环境变量(LOGSENE_TOKEN=您的应用程序令牌),Sematext Docker 代理就会将日志发送到正确的索引条目!这样,您根本不需要中央配置文件来映射容器和索引项目/令牌,因此日志路由变得非常灵活、动态和弹性。

Integrated Log Parser 日志处理基于 Docker API 和一个名为 logagent-js 的库,该库由 Sematext 开源。该分析框架包括用于日志格式检测和分析标准正式 Docker 容器使用的不同日志格式的模式:

提示:如果您想创建自定义模式,请将它们添加到 Rancher 目录模板中名为 LOGAGENT_PATTERNS 的字段中。自动容器日志记录 Geo-IP 增强功能 从 Docker 容器外部获取日志到 采集 运输和分析节省了大量时间,但一些应用程序日志需要其他数据源的额外增强功能。一种常见的情况是增强Web Server的日志信息(或任何收录IP地址信息的日志),并为日志中的IP地址提供其地理位置信息。

Sematext Docker Agent 支持 docker 日志的 Geo-IP 丰富。它使用 Maxmind Geo-IP 轻量级数据库,为您提供定期更新的信息,而无需停止容器或为其挂载收录 Geo-IP 数据库的新卷,或任何其他手动操作。

提示:要启用 Geo-IP 增强功能,请设置环境变量 GEOIP_ENABLED=true。过滤容器日志 在某些情况下,我们只需要采集重要应用程序的日志,而忽略低优先级或嘈杂的服务日志(例如那些经常清理的日志)。这样,我们可以使用白名单或黑名单(容器名称或镜像名称)来处理这些容器,其设置使用正则表达式匹配对应的元数据字段。

如何使用 Sematext Catalog 项目 在 Rancher 的 UI 中,进入社区的 Catalog 项目列表,搜索关键字“sematext”、“monitoring”或“logs”。

点击“查看详情”,在“配置选项”选项中输入SPM和Logsene App的token。从这里您可以注册和创建您的 SPM 和 Logsene 应用程序,然后获取这些访问令牌。如果您的 Rancher 集群在防火墙(代理)后面运行,您需要在 HTTPS_PROXY 或 HTTP_PROXY 环境变量中填写代理 URL。如果您还在此集群中运行 Kubernetes,请选择 KUBERNETES=1。

如果要采集所有日志,容器或镜像名称不要填写任何过滤值,只需点击“启动”即可。

结束语 我们希望这篇对 Rancher 平台中 Sematext Docker Agent 的介绍可以帮助您开始监控和记录 Docker,而不必担心繁琐模式的大杂烩。本项目完整的配置参数可以参考参考。我们相信新的目录模板已经涵盖了最常见的选项。如果您发现缺少一些重要的项目,请将它们提交到 Rancher 社区目录(提交问题或拉取请求)。尝试使用 Rancher 的 Sematext Docker Agent,所有服务将被轻松接管,您将高枕无忧。Rancher 社区目录让日志监控系统在瞬间启动和运行变得非常容易。

完整的采集神器( 一下file_get_contents函数可以获取远程链接数据的方法)

采集交流 • 优采云 发表了文章 • 0 个评论 • 171 次浏览 • 2022-02-16 08:15

一下file_get_contents函数可以获取远程链接数据的方法)

php采集神器cURL用法详解

做过data采集的朋友,cURL一定不会陌生。虽然PHP中有一个file_get_contents函数可以获取远程链接的数据,但是它的可控性太差了。对于各种复杂的情况采集,file_get_contents 显得有些力不从心。因此,本文将向您介绍采集神器cURL的使用。

我先给大家补充一下file_get_contents函数是如何获取远程链接数据的。

这段代码会直接使用curl来显示文件内容,但是问题来了,因为curl是php的扩展,有些主机为了安全会金庸curl,而宁外php在本地调试的时候也会关闭curl,所以会报错发生。所以这段代码不可取,所以云洛给他重写了

修改后的版本是对curl扩展做判断,看服务器是否开启了curl扩展。如果打开则直接显示该文件,如果未打开则显示提示文字。

虽然问题已经解决,但还有另一个问题。我只是显示一段文字,并没有用任何东西来做大事,那我为什么要写这么多代码呢??

经过一番废话测试,发现file_get_contents获取远程文件内容并不比curl慢,而且在某些文件较少的情况下可能比curl扩展快很多,于是我又重写了代码

工具

火狐+萤火虫

“要想把工作做好,就必须先利好自己的工具。” 在分析案例之前,我们先学习一下如何使用神器 Firebug 来获取我们需要的信息。

使用F12打开Firebug,我们可以得到如图所示的界面(一):

1、箭头图标是“元素选择”工具。单击一次将突出显示该图标。同时,鼠标在页面中的移动会同时选中HTML菜单中的相应内容。当元素被设置时,图标高亮被取消。如图(二):

Firebug 视图元素

2、控制台

JS中console.log系列函数的打印输出到这里。

3、HTML

HTML内容,注意这里看到的不一定是采集要解析的内容,采集时对内容的分析总是基于查看源码(Ctrl+U ),这里只是为了快速定位元素结构,然后在源码中选择一个专门的引用来定位对应的位置。

例如,如果您在 HTML 中看到一个标签

演示

, 但是你看源码时看到的可能是

演示

,如果按照前者对采集的内容进行正则匹配,则不会得到结果。

4、CSS

这是CSS文件内容

5、脚本

这是Javascript文件内容

6、DOM

dom节点内容

7、网络

每个请求链接的数据,这里是我们采集要关注和分析的地方,它可以显示每个请求的参数、请求头、cookie数据等。在页面提交会刷新的情况下,需要使用hold,这样刷新后页面请求内容会保留在控制台中,如图(三):

此外,Firefox还有一个Tamper data扩展,也可以获取请求数据,必要时可以安装使用。

8、Cookie

Cookie 数据

在图中(一),我们也看到下面有很多可选的小菜单项,其中keep是我们要注意的。当它被选中时,即使提交了表单并且页面是刷新后,下方内容区的数据依然会被保留,这对于分析提交的数据尤为关键。

总结

我们在分析采集的请求时,主要关心的是“网络”菜单中的请求数据。如有必要,使用“保持”查看刷新页面的请求数据。在发出请求之前,您可以使用“清除”清除以下内容。

案例分析

一、简单采集

这里所说的简单采集是指单个页面GET请求的采集,简单到即使通过file_get_contents函数也可以轻松获取页面返回结果。

代码片段 file_get_contents

<p> 查看全部

完整的采集神器(

一下file_get_contents函数可以获取远程链接数据的方法)

php采集神器cURL用法详解

做过data采集的朋友,cURL一定不会陌生。虽然PHP中有一个file_get_contents函数可以获取远程链接的数据,但是它的可控性太差了。对于各种复杂的情况采集,file_get_contents 显得有些力不从心。因此,本文将向您介绍采集神器cURL的使用。

我先给大家补充一下file_get_contents函数是如何获取远程链接数据的。

这段代码会直接使用curl来显示文件内容,但是问题来了,因为curl是php的扩展,有些主机为了安全会金庸curl,而宁外php在本地调试的时候也会关闭curl,所以会报错发生。所以这段代码不可取,所以云洛给他重写了

修改后的版本是对curl扩展做判断,看服务器是否开启了curl扩展。如果打开则直接显示该文件,如果未打开则显示提示文字。

虽然问题已经解决,但还有另一个问题。我只是显示一段文字,并没有用任何东西来做大事,那我为什么要写这么多代码呢??

经过一番废话测试,发现file_get_contents获取远程文件内容并不比curl慢,而且在某些文件较少的情况下可能比curl扩展快很多,于是我又重写了代码

工具

火狐+萤火虫

“要想把工作做好,就必须先利好自己的工具。” 在分析案例之前,我们先学习一下如何使用神器 Firebug 来获取我们需要的信息。

使用F12打开Firebug,我们可以得到如图所示的界面(一):

1、箭头图标是“元素选择”工具。单击一次将突出显示该图标。同时,鼠标在页面中的移动会同时选中HTML菜单中的相应内容。当元素被设置时,图标高亮被取消。如图(二):

Firebug 视图元素

2、控制台

JS中console.log系列函数的打印输出到这里。

3、HTML

HTML内容,注意这里看到的不一定是采集要解析的内容,采集时对内容的分析总是基于查看源码(Ctrl+U ),这里只是为了快速定位元素结构,然后在源码中选择一个专门的引用来定位对应的位置。

例如,如果您在 HTML 中看到一个标签

演示

, 但是你看源码时看到的可能是

演示

,如果按照前者对采集的内容进行正则匹配,则不会得到结果。

4、CSS

这是CSS文件内容

5、脚本

这是Javascript文件内容

6、DOM

dom节点内容

7、网络

每个请求链接的数据,这里是我们采集要关注和分析的地方,它可以显示每个请求的参数、请求头、cookie数据等。在页面提交会刷新的情况下,需要使用hold,这样刷新后页面请求内容会保留在控制台中,如图(三):

此外,Firefox还有一个Tamper data扩展,也可以获取请求数据,必要时可以安装使用。

8、Cookie

Cookie 数据

在图中(一),我们也看到下面有很多可选的小菜单项,其中keep是我们要注意的。当它被选中时,即使提交了表单并且页面是刷新后,下方内容区的数据依然会被保留,这对于分析提交的数据尤为关键。

总结

我们在分析采集的请求时,主要关心的是“网络”菜单中的请求数据。如有必要,使用“保持”查看刷新页面的请求数据。在发出请求之前,您可以使用“清除”清除以下内容。

案例分析

一、简单采集

这里所说的简单采集是指单个页面GET请求的采集,简单到即使通过file_get_contents函数也可以轻松获取页面返回结果。

代码片段 file_get_contents

<p>

完整的采集神器(完整的采集神器,适合java,推荐picasa+flashplayer)

采集交流 • 优采云 发表了文章 • 0 个评论 • 106 次浏览 • 2022-02-12 22:00

完整的采集神器,适合java,

推荐picasa+flashplayer,rss直接由浏览器里解析,

原生android用的evernote-rss方案。firefoxgo1.11采用此方案。或其它厂商仿evernote的,如feedly。

-rss-posts/blob/master/evernote_rss.js/-django-resources/evernote.py

有个开放的第三方中转站,

和网页本身有关

编辑rss/redditrecipes,但是不知道不是第三方rssreader。

/analyticalchrones/

omnifocus的集成rss项目

formacevernotersstimeline/,libreofficeoutlook等都可以,picasa调用flashreader/outlook调用

update:12.06如何在safari中调用chromerss

iphone可用readitwell

文章有很多rss地址的话,可以尝试以下这种方式打开reeder,

gitsync也可以,bushi.

推荐用电脑做阅读器,然后用在线rss客户端阅读。

reederforandroid或者evernote都可以。 查看全部

完整的采集神器(完整的采集神器,适合java,推荐picasa+flashplayer)

完整的采集神器,适合java,

推荐picasa+flashplayer,rss直接由浏览器里解析,

原生android用的evernote-rss方案。firefoxgo1.11采用此方案。或其它厂商仿evernote的,如feedly。

-rss-posts/blob/master/evernote_rss.js/-django-resources/evernote.py

有个开放的第三方中转站,

和网页本身有关

编辑rss/redditrecipes,但是不知道不是第三方rssreader。

/analyticalchrones/

omnifocus的集成rss项目

formacevernotersstimeline/,libreofficeoutlook等都可以,picasa调用flashreader/outlook调用

update:12.06如何在safari中调用chromerss

iphone可用readitwell

文章有很多rss地址的话,可以尝试以下这种方式打开reeder,

gitsync也可以,bushi.

推荐用电脑做阅读器,然后用在线rss客户端阅读。

reederforandroid或者evernote都可以。

完整的采集神器(两个和Logsene的监控与日志工具对比(一)(组图))

采集交流 • 优采云 发表了文章 • 0 个评论 • 116 次浏览 • 2022-02-09 21:07

Rancher 社区维护的应用商店最近迎来了两个明星项目——SPM 和来自 Sematext 的监控和日志工具 Logsene。如果您已经熟悉 Logstash、Kibana、Prometheus、Grafana 等监控或日志解决方案,那么请仔细阅读本文,它将向您展示 SPM 和 Logsene 为 Rancher 用户带来的功能,以及其他解决方案有哪些不同之处。

联系 Sematext Docker 代理

Sematext Docker Agent是当前Docker原生监控和日志采集Agent程序。它在每个 Docker 主机上运行一个非常小的容器来采集所有集群节点和这些节点上的容器的日志、系统指标和事件。Agent 代理监控 Rancher 管理的所有节点。部署 Sematext Docker Agent 后,所有日志、Docker 事件、各种指标都可以对外访问。

这将变得有价值,为什么?因为这意味着您不再需要花费数小时甚至数天的时间来弄清楚 采集 您需要什么数据或如何绘制它。另外,您不需要花费资源来维护自己的日志监控系统,您的Docker系统指标和事件会输出到SPM,日志会输出到Logsene(SPM是一个支持集成的应用程序性能监控服务,其中当然还包括 Docker,而 Logsene 是一个日志管理服务,一个托管在 Rancher 中的 ELK 应用程序堆栈,可以很好地与 Kibana 和 Grafana 配合使用)

DevOps 工具对比

Docker 日志和指标处理有一些开源工具供我们选择,例如 cAdvisor 和 Logspout。不幸的是,这些工具都不够全面。一种解决方案是集成一系列工具来实现目标,但这样做的结果是使系统朝着“Franken-monitoring(指技术的大杂烩,每个组件都没有按承诺发挥作用)”的方向发展,并且用户因此将背负沉重的技术债务,没有人愿意解决如此复杂的故障。所以另一种解决方案是像 Sematext Docker Agent 这样的工具,它只是结合了 cAdvisor 和 Logspout,其功能特别侧重于日志管理,例如格式检查、日志解析、数据改进(Geo-IP 地址地理位置信息)、元数据标签等

通过 Rancher Catalog 配置 Sematext Docker 代理

要在 Rancher 平台上设置 Sematext Docker 代理,您只需选择适当的目录模板(在 Rancher 的社区目录条目下查找“Sematext”)。让我们快速了解一下 Sematex 提供哪些功能?如何在 Rancher 平台上进行设置?

Docker Compose 和 Kubernetes 自动日志标签

所有日志都标有元数据,其中包括对 Docker/Rancher Compose 项目和 Kubernetes 的支持:

对于 Docker 容器

为 Docker/Rancher 编写

对于 Kubernetes

请注意,Kubernetes 容器的日志与其他 Docker 容器的日志没有太大区别,但是 Kubernetes 用户需要访问已部署 pod 的日志,因此抓取 Kubernetes 特定信息以进行日志搜索非常有用,例如:

提示:要启用 Kubernetes 标签,请设置 Kubernetes=1

日志路由

对于较大的部署,您可能需要为不同的租户或应用程序的日志建立索引,并将它们输出到不同的路径或Logsene应用程序进行处理(这样您也可以区分不同用户对不同日志的访问权限)。我们让这变得非常简单:只需将 Docker 标记添加到您的容器,或设置 LOGSENE_TOKEN 环境变量(LOGSENE_TOKEN=您的应用程序令牌),Sematext Docker 代理就会将日志发送到正确的索引条目!这样,您根本不需要中央配置文件来映射容器和索引项目/令牌,因此日志路由变得非常灵活、动态和弹性。

集成日志解析器

日志处理基于 Docker API 和一个名为 logagent-js 的库,该库由 Sematext 开源。该分析框架包括用于日志格式检测和分析标准正式 Docker 容器使用的不同日志格式的模式:

提示:如果您想创建自定义模式,请将它们添加到 Rancher 目录模板中名为 LOGAGENT_PATTERNS 的字段中。

自动容器日志记录 Geo-IP 增强功能

从 Docker 容器外部获取 采集 发送和分析日志节省了大量时间,但某些应用程序日志需要其他数据源的额外增强。一种常见的情况是增强Web Server的日志信息(或任何收录IP地址信息的日志),并为日志中的IP地址提供其地理位置信息。

Sematext Docker Agent 支持 docker 日志的 Geo-IP 丰富。它使用 Maxmind Geo-IP 轻量级数据库,为您提供定期更新的信息,而无需停止容器或为其挂载收录 Geo-IP 数据库的新卷,或任何其他手动操作。

提示:要启用 Geo-IP 增强功能,请设置环境变量 GEOIP_ENABLED=true。

过滤容器日志

在某些情况下,我们只需要采集重要的应用程序日志,而忽略那些优先级较低或噪音较大的服务日志(例如那些经常被清理的)。这样,我们可以使用白名单或黑名单(容器名称或镜像名称)来处理这些容器,其设置使用正则表达式匹配对应的元数据字段。

白名单容器

MATCH_BY_NAME

将容器名称列入白名单的正则表达式

MATCH_BY_IMAGE

正则表达式将图像名称列入白名单

黑名单容器

SKIP_BY_NAME

正则表达式将容器名称列入黑名单并忽略日志中的容器

SKIP_BY_IMAGE

正则表达式将图片名称列入黑名单,忽略日志中的图片

如何使用 Sematext 目录项

在 Rancher 的 UI 中,进入社区的 Catalog 项目列表并搜索关键字“sematext”、“monitoring”或“logs”。

点击“查看详情”,在“配置选项”选项中输入SPM和Logsene App的token。您可以从这里注册并创建您的 SPM 和 Logsene 应用程序,然后您可以获得这些访问令牌(令牌)。如果您的 Rancher 集群在防火墙(代理)后面运行,您需要在 HTTPS_PROXY 或 HTTP_PROXY 环境变量中填写代理 URL。如果您还在此集群中运行 Kubernetes,请选择 KUBERNETES=1。

如果要采集所有日志,容器或镜像名称不要填写任何过滤值,只需点击“启动”即可。

总结

我们希望这篇对 Rancher 平台中 Sematext Docker 代理的介绍可以帮助您开始使用 Docker 监控和日志记录,而无需大杂烩模式。项目的完整配置参数可从 Github 获取,以供参考。我们相信新的 Catalog 模板已经涵盖了最常见的选项,如果您发现缺少一些重要的项目,请将它们提交到 Rancher 社区目录(提交问题或拉取请求)。尝试使用 Rancher 的 Sematext Docker Agent,所有服务将被轻松接管,您将高枕无忧。Rancher 社区目录让日志监控系统在瞬间启动和运行变得非常容易。 查看全部

完整的采集神器(两个和Logsene的监控与日志工具对比(一)(组图))

Rancher 社区维护的应用商店最近迎来了两个明星项目——SPM 和来自 Sematext 的监控和日志工具 Logsene。如果您已经熟悉 Logstash、Kibana、Prometheus、Grafana 等监控或日志解决方案,那么请仔细阅读本文,它将向您展示 SPM 和 Logsene 为 Rancher 用户带来的功能,以及其他解决方案有哪些不同之处。

联系 Sematext Docker 代理

Sematext Docker Agent是当前Docker原生监控和日志采集Agent程序。它在每个 Docker 主机上运行一个非常小的容器来采集所有集群节点和这些节点上的容器的日志、系统指标和事件。Agent 代理监控 Rancher 管理的所有节点。部署 Sematext Docker Agent 后,所有日志、Docker 事件、各种指标都可以对外访问。

这将变得有价值,为什么?因为这意味着您不再需要花费数小时甚至数天的时间来弄清楚 采集 您需要什么数据或如何绘制它。另外,您不需要花费资源来维护自己的日志监控系统,您的Docker系统指标和事件会输出到SPM,日志会输出到Logsene(SPM是一个支持集成的应用程序性能监控服务,其中当然还包括 Docker,而 Logsene 是一个日志管理服务,一个托管在 Rancher 中的 ELK 应用程序堆栈,可以很好地与 Kibana 和 Grafana 配合使用)

DevOps 工具对比

Docker 日志和指标处理有一些开源工具供我们选择,例如 cAdvisor 和 Logspout。不幸的是,这些工具都不够全面。一种解决方案是集成一系列工具来实现目标,但这样做的结果是使系统朝着“Franken-monitoring(指技术的大杂烩,每个组件都没有按承诺发挥作用)”的方向发展,并且用户因此将背负沉重的技术债务,没有人愿意解决如此复杂的故障。所以另一种解决方案是像 Sematext Docker Agent 这样的工具,它只是结合了 cAdvisor 和 Logspout,其功能特别侧重于日志管理,例如格式检查、日志解析、数据改进(Geo-IP 地址地理位置信息)、元数据标签等

通过 Rancher Catalog 配置 Sematext Docker 代理

要在 Rancher 平台上设置 Sematext Docker 代理,您只需选择适当的目录模板(在 Rancher 的社区目录条目下查找“Sematext”)。让我们快速了解一下 Sematex 提供哪些功能?如何在 Rancher 平台上进行设置?

Docker Compose 和 Kubernetes 自动日志标签

所有日志都标有元数据,其中包括对 Docker/Rancher Compose 项目和 Kubernetes 的支持:

对于 Docker 容器

为 Docker/Rancher 编写

对于 Kubernetes

请注意,Kubernetes 容器的日志与其他 Docker 容器的日志没有太大区别,但是 Kubernetes 用户需要访问已部署 pod 的日志,因此抓取 Kubernetes 特定信息以进行日志搜索非常有用,例如:

提示:要启用 Kubernetes 标签,请设置 Kubernetes=1

日志路由

对于较大的部署,您可能需要为不同的租户或应用程序的日志建立索引,并将它们输出到不同的路径或Logsene应用程序进行处理(这样您也可以区分不同用户对不同日志的访问权限)。我们让这变得非常简单:只需将 Docker 标记添加到您的容器,或设置 LOGSENE_TOKEN 环境变量(LOGSENE_TOKEN=您的应用程序令牌),Sematext Docker 代理就会将日志发送到正确的索引条目!这样,您根本不需要中央配置文件来映射容器和索引项目/令牌,因此日志路由变得非常灵活、动态和弹性。

集成日志解析器

日志处理基于 Docker API 和一个名为 logagent-js 的库,该库由 Sematext 开源。该分析框架包括用于日志格式检测和分析标准正式 Docker 容器使用的不同日志格式的模式:

提示:如果您想创建自定义模式,请将它们添加到 Rancher 目录模板中名为 LOGAGENT_PATTERNS 的字段中。

自动容器日志记录 Geo-IP 增强功能

从 Docker 容器外部获取 采集 发送和分析日志节省了大量时间,但某些应用程序日志需要其他数据源的额外增强。一种常见的情况是增强Web Server的日志信息(或任何收录IP地址信息的日志),并为日志中的IP地址提供其地理位置信息。

Sematext Docker Agent 支持 docker 日志的 Geo-IP 丰富。它使用 Maxmind Geo-IP 轻量级数据库,为您提供定期更新的信息,而无需停止容器或为其挂载收录 Geo-IP 数据库的新卷,或任何其他手动操作。

提示:要启用 Geo-IP 增强功能,请设置环境变量 GEOIP_ENABLED=true。

过滤容器日志

在某些情况下,我们只需要采集重要的应用程序日志,而忽略那些优先级较低或噪音较大的服务日志(例如那些经常被清理的)。这样,我们可以使用白名单或黑名单(容器名称或镜像名称)来处理这些容器,其设置使用正则表达式匹配对应的元数据字段。

白名单容器

MATCH_BY_NAME

将容器名称列入白名单的正则表达式

MATCH_BY_IMAGE

正则表达式将图像名称列入白名单

黑名单容器

SKIP_BY_NAME

正则表达式将容器名称列入黑名单并忽略日志中的容器

SKIP_BY_IMAGE

正则表达式将图片名称列入黑名单,忽略日志中的图片

如何使用 Sematext 目录项

在 Rancher 的 UI 中,进入社区的 Catalog 项目列表并搜索关键字“sematext”、“monitoring”或“logs”。

点击“查看详情”,在“配置选项”选项中输入SPM和Logsene App的token。您可以从这里注册并创建您的 SPM 和 Logsene 应用程序,然后您可以获得这些访问令牌(令牌)。如果您的 Rancher 集群在防火墙(代理)后面运行,您需要在 HTTPS_PROXY 或 HTTP_PROXY 环境变量中填写代理 URL。如果您还在此集群中运行 Kubernetes,请选择 KUBERNETES=1。

如果要采集所有日志,容器或镜像名称不要填写任何过滤值,只需点击“启动”即可。

总结

我们希望这篇对 Rancher 平台中 Sematext Docker 代理的介绍可以帮助您开始使用 Docker 监控和日志记录,而无需大杂烩模式。项目的完整配置参数可从 Github 获取,以供参考。我们相信新的 Catalog 模板已经涵盖了最常见的选项,如果您发现缺少一些重要的项目,请将它们提交到 Rancher 社区目录(提交问题或拉取请求)。尝试使用 Rancher 的 Sematext Docker Agent,所有服务将被轻松接管,您将高枕无忧。Rancher 社区目录让日志监控系统在瞬间启动和运行变得非常容易。

完整的采集神器(两个和Logsene的监控与日志工具对比(一)(组图))

采集交流 • 优采云 发表了文章 • 0 个评论 • 143 次浏览 • 2022-02-09 21:02

Rancher 社区维护的应用商店最近迎来了两个明星项目——SPM 和来自 Sematext 的监控和日志工具 Logsene。如果您已经熟悉 Logstash、Kibana、Prometheus、Grafana 等监控或日志解决方案,那么请仔细阅读本文,它将向您展示 SPM 和 Logsene 为 Rancher 用户带来的功能,以及其他解决方案有哪些不同之处。

联系 Sematext Docker 代理

Sematext Docker Agent是当前Docker原生监控和日志采集Agent程序。它在每个 Docker 主机上运行一个非常小的容器来采集所有集群节点和这些节点上的容器的日志、系统指标和事件。Agent 代理监控 Rancher 管理的所有节点。部署 Sematext Docker Agent 后,所有日志、Docker 事件、各种指标都可以对外访问。

这将变得有价值,为什么?因为这意味着您不再需要花费数小时甚至数天的时间来弄清楚 采集 您需要什么数据或如何绘制它。另外,您不需要花费资源来维护自己的日志监控系统,您的Docker系统指标和事件会输出到SPM,日志会输出到Logsene(SPM是一个支持集成的应用程序性能监控服务,其中当然还包括 Docker,而 Logsene 是一个日志管理服务,一个托管在 Rancher 中的 ELK 应用程序堆栈,可以很好地与 Kibana 和 Grafana 配合使用)

DevOps 工具对比

Docker 日志和指标处理有一些开源工具供我们选择,例如 cAdvisor 和 Logspout。不幸的是,这些工具都不够全面。一种解决方案是集成一系列工具来实现目标,但这样做的结果是使系统朝着“Franken-monitoring(指技术的大杂烩,每个组件都没有按承诺发挥作用)”的方向发展,并且用户因此将背负沉重的技术债务,没有人愿意解决如此复杂的故障。所以另一种解决方案是像 Sematext Docker Agent 这样的工具,它只是结合了 cAdvisor 和 Logspout,其功能特别侧重于日志管理,例如格式检查、日志解析、数据改进(Geo-IP 地址地理位置信息)、元数据标签等

通过 Rancher Catalog 配置 Sematext Docker 代理

要在 Rancher 平台上设置 Sematext Docker 代理,您只需选择适当的目录模板(在 Rancher 的社区目录条目下查找“Sematext”)。让我们快速了解一下 Sematex 提供哪些功能?如何在 Rancher 平台上进行设置?

Docker Compose 和 Kubernetes 自动日志标签

所有日志都标有元数据,其中包括对 Docker/Rancher Compose 项目和 Kubernetes 的支持:

对于 Docker 容器

为 Docker/Rancher 编写

对于 Kubernetes

请注意,Kubernetes 容器的日志与其他 Docker 容器的日志没有太大区别,但是 Kubernetes 用户需要访问已部署 pod 的日志,因此抓取 Kubernetes 特定信息以进行日志搜索非常有用,例如:

提示:要启用 Kubernetes 标签,请设置 Kubernetes=1

日志路由

对于较大的部署,您可能需要为不同的租户或应用程序的日志建立索引,并将它们输出到不同的路径或Logsene应用程序进行处理(这样您也可以区分不同用户对不同日志的访问权限)。我们让这变得非常简单:只需将 Docker 标记添加到您的容器,或设置 LOGSENE_TOKEN 环境变量(LOGSENE_TOKEN=您的应用程序令牌),Sematext Docker 代理就会将日志发送到正确的索引条目!这样,您根本不需要中央配置文件来映射容器和索引项目/令牌,因此日志路由变得非常灵活、动态和弹性。

集成日志解析器

日志处理基于 Docker API 和一个名为 logagent-js 的库,该库由 Sematext 开源。该分析框架包括用于日志格式检测和分析标准正式 Docker 容器使用的不同日志格式的模式:

提示:如果您想创建自定义模式,请将它们添加到 Rancher 目录模板中名为 LOGAGENT_PATTERNS 的字段中。

自动容器日志记录 Geo-IP 增强功能

从 Docker 容器外部获取 采集 发送和分析日志节省了大量时间,但某些应用程序日志需要其他数据源的额外增强。一种常见的情况是增强Web Server的日志信息(或任何收录IP地址信息的日志),并为日志中的IP地址提供其地理位置信息。

Sematext Docker Agent 支持 docker 日志的 Geo-IP 丰富。它使用 Maxmind Geo-IP 轻量级数据库,为您提供定期更新的信息,而无需停止容器或为其挂载收录 Geo-IP 数据库的新卷,或任何其他手动操作。

提示:要启用 Geo-IP 增强功能,请设置环境变量 GEOIP_ENABLED=true。

过滤容器日志

在某些情况下,我们只需要采集重要的应用程序日志,而忽略那些优先级较低或噪音较大的服务日志(例如那些经常被清理的)。这样,我们可以使用白名单或黑名单(容器名称或镜像名称)来处理这些容器,其设置使用正则表达式匹配对应的元数据字段。

白名单容器

MATCH_BY_NAME

将容器名称列入白名单的正则表达式

MATCH_BY_IMAGE

正则表达式将图像名称列入白名单

黑名单容器

SKIP_BY_NAME

正则表达式将容器名称列入黑名单并忽略日志中的容器

SKIP_BY_IMAGE

正则表达式将图片名称列入黑名单,忽略日志中的图片

如何使用 Sematext 目录项

在 Rancher 的 UI 中,进入社区的 Catalog 项目列表并搜索关键字“sematext”、“monitoring”或“logs”。

点击“查看详情”,在“配置选项”选项中输入SPM和Logsene App的token。您可以从这里注册并创建您的 SPM 和 Logsene 应用程序,然后您可以获得这些访问令牌(令牌)。如果您的 Rancher 集群在防火墙(代理)后面运行,您需要在 HTTPS_PROXY 或 HTTP_PROXY 环境变量中填写代理 URL。如果您还在此集群中运行 Kubernetes,请选择 KUBERNETES=1。

如果要采集所有日志,容器或镜像名称不要填写任何过滤值,只需点击“启动”即可。

总结

我们希望这篇对 Rancher 平台中 Sematext Docker 代理的介绍可以帮助您开始使用 Docker 监控和日志记录,而无需大杂烩模式。项目的完整配置参数可从 Github 获取,以供参考。我们相信新的 Catalog 模板已经涵盖了最常见的选项,如果您发现缺少一些重要的项目,请将它们提交到 Rancher 社区目录(提交问题或拉取请求)。尝试使用 Rancher 的 Sematext Docker Agent,所有服务将被轻松接管,您将高枕无忧。Rancher 社区目录让日志监控系统在瞬间启动和运行变得非常容易。 查看全部

完整的采集神器(两个和Logsene的监控与日志工具对比(一)(组图))

Rancher 社区维护的应用商店最近迎来了两个明星项目——SPM 和来自 Sematext 的监控和日志工具 Logsene。如果您已经熟悉 Logstash、Kibana、Prometheus、Grafana 等监控或日志解决方案,那么请仔细阅读本文,它将向您展示 SPM 和 Logsene 为 Rancher 用户带来的功能,以及其他解决方案有哪些不同之处。

联系 Sematext Docker 代理

Sematext Docker Agent是当前Docker原生监控和日志采集Agent程序。它在每个 Docker 主机上运行一个非常小的容器来采集所有集群节点和这些节点上的容器的日志、系统指标和事件。Agent 代理监控 Rancher 管理的所有节点。部署 Sematext Docker Agent 后,所有日志、Docker 事件、各种指标都可以对外访问。

这将变得有价值,为什么?因为这意味着您不再需要花费数小时甚至数天的时间来弄清楚 采集 您需要什么数据或如何绘制它。另外,您不需要花费资源来维护自己的日志监控系统,您的Docker系统指标和事件会输出到SPM,日志会输出到Logsene(SPM是一个支持集成的应用程序性能监控服务,其中当然还包括 Docker,而 Logsene 是一个日志管理服务,一个托管在 Rancher 中的 ELK 应用程序堆栈,可以很好地与 Kibana 和 Grafana 配合使用)

DevOps 工具对比

Docker 日志和指标处理有一些开源工具供我们选择,例如 cAdvisor 和 Logspout。不幸的是,这些工具都不够全面。一种解决方案是集成一系列工具来实现目标,但这样做的结果是使系统朝着“Franken-monitoring(指技术的大杂烩,每个组件都没有按承诺发挥作用)”的方向发展,并且用户因此将背负沉重的技术债务,没有人愿意解决如此复杂的故障。所以另一种解决方案是像 Sematext Docker Agent 这样的工具,它只是结合了 cAdvisor 和 Logspout,其功能特别侧重于日志管理,例如格式检查、日志解析、数据改进(Geo-IP 地址地理位置信息)、元数据标签等

通过 Rancher Catalog 配置 Sematext Docker 代理

要在 Rancher 平台上设置 Sematext Docker 代理,您只需选择适当的目录模板(在 Rancher 的社区目录条目下查找“Sematext”)。让我们快速了解一下 Sematex 提供哪些功能?如何在 Rancher 平台上进行设置?

Docker Compose 和 Kubernetes 自动日志标签

所有日志都标有元数据,其中包括对 Docker/Rancher Compose 项目和 Kubernetes 的支持:

对于 Docker 容器

为 Docker/Rancher 编写

对于 Kubernetes

请注意,Kubernetes 容器的日志与其他 Docker 容器的日志没有太大区别,但是 Kubernetes 用户需要访问已部署 pod 的日志,因此抓取 Kubernetes 特定信息以进行日志搜索非常有用,例如:

提示:要启用 Kubernetes 标签,请设置 Kubernetes=1

日志路由

对于较大的部署,您可能需要为不同的租户或应用程序的日志建立索引,并将它们输出到不同的路径或Logsene应用程序进行处理(这样您也可以区分不同用户对不同日志的访问权限)。我们让这变得非常简单:只需将 Docker 标记添加到您的容器,或设置 LOGSENE_TOKEN 环境变量(LOGSENE_TOKEN=您的应用程序令牌),Sematext Docker 代理就会将日志发送到正确的索引条目!这样,您根本不需要中央配置文件来映射容器和索引项目/令牌,因此日志路由变得非常灵活、动态和弹性。

集成日志解析器

日志处理基于 Docker API 和一个名为 logagent-js 的库,该库由 Sematext 开源。该分析框架包括用于日志格式检测和分析标准正式 Docker 容器使用的不同日志格式的模式:

提示:如果您想创建自定义模式,请将它们添加到 Rancher 目录模板中名为 LOGAGENT_PATTERNS 的字段中。

自动容器日志记录 Geo-IP 增强功能

从 Docker 容器外部获取 采集 发送和分析日志节省了大量时间,但某些应用程序日志需要其他数据源的额外增强。一种常见的情况是增强Web Server的日志信息(或任何收录IP地址信息的日志),并为日志中的IP地址提供其地理位置信息。

Sematext Docker Agent 支持 docker 日志的 Geo-IP 丰富。它使用 Maxmind Geo-IP 轻量级数据库,为您提供定期更新的信息,而无需停止容器或为其挂载收录 Geo-IP 数据库的新卷,或任何其他手动操作。

提示:要启用 Geo-IP 增强功能,请设置环境变量 GEOIP_ENABLED=true。

过滤容器日志

在某些情况下,我们只需要采集重要的应用程序日志,而忽略那些优先级较低或噪音较大的服务日志(例如那些经常被清理的)。这样,我们可以使用白名单或黑名单(容器名称或镜像名称)来处理这些容器,其设置使用正则表达式匹配对应的元数据字段。

白名单容器

MATCH_BY_NAME

将容器名称列入白名单的正则表达式

MATCH_BY_IMAGE

正则表达式将图像名称列入白名单

黑名单容器

SKIP_BY_NAME

正则表达式将容器名称列入黑名单并忽略日志中的容器

SKIP_BY_IMAGE

正则表达式将图片名称列入黑名单,忽略日志中的图片

如何使用 Sematext 目录项

在 Rancher 的 UI 中,进入社区的 Catalog 项目列表并搜索关键字“sematext”、“monitoring”或“logs”。

点击“查看详情”,在“配置选项”选项中输入SPM和Logsene App的token。您可以从这里注册并创建您的 SPM 和 Logsene 应用程序,然后您可以获得这些访问令牌(令牌)。如果您的 Rancher 集群在防火墙(代理)后面运行,您需要在 HTTPS_PROXY 或 HTTP_PROXY 环境变量中填写代理 URL。如果您还在此集群中运行 Kubernetes,请选择 KUBERNETES=1。

如果要采集所有日志,容器或镜像名称不要填写任何过滤值,只需点击“启动”即可。

总结

我们希望这篇对 Rancher 平台中 Sematext Docker 代理的介绍可以帮助您开始使用 Docker 监控和日志记录,而无需大杂烩模式。项目的完整配置参数可从 Github 获取,以供参考。我们相信新的 Catalog 模板已经涵盖了最常见的选项,如果您发现缺少一些重要的项目,请将它们提交到 Rancher 社区目录(提交问题或拉取请求)。尝试使用 Rancher 的 Sematext Docker Agent,所有服务将被轻松接管,您将高枕无忧。Rancher 社区目录让日志监控系统在瞬间启动和运行变得非常容易。

完整的采集神器(php采集神器cURL使用方法详解,采集curl对于做过数据采集的人来说)

采集交流 • 优采云 发表了文章 • 0 个评论 • 114 次浏览 • 2022-02-08 08:20

php采集神器cURL用法详解,采集curl

做过data采集的朋友,cURL一定不会陌生。虽然PHP中有一个file_get_contents函数可以获取远程链接的数据,但是它的可控性太差了。对于各种复杂的情况采集,file_get_contents 显得有些力不从心。因此,本文将向您介绍采集神器cURL的使用。

我先给大家补充一下file_get_contents函数是如何获取远程链接数据的。

这段代码会直接使用curl来显示文件的内容,但是问题来了,因为curl是php的扩展,有些主机为了安全会金庸curl,而宁外php在本地调试的时候也会关闭curl,所以一个会发生错误。所以这段代码不可取,所以云洛给他重写了

修改后的版本是对curl扩展做判断,看服务器是否开启了curl扩展。如果打开则直接显示该文件,如果未打开则显示提示文字。

虽然问题已经解决,但还有另一个问题。我只是显示一段文字,并没有用任何东西来做大事,那我为什么要写这么多代码呢??

经过一番废话测试,发现file_get_contents获取远程文件内容并不比curl慢,而且在某些文件较少的情况下可能比curl扩展快很多,于是我又重写了代码

工具

火狐+萤火虫

“要想把工作做好,就必须先利好自己的工具。” 在分析案例之前,我们先学习一下如何使用神器 Firebug 来获取我们需要的信息。

使用F12打开Firebug,我们可以得到如图所示的界面(一):

1、箭头图标是“元素选择”工具。单击一次将突出显示该图标。同时,鼠标在页面中的移动会同时选中HTML菜单中的相应内容。当元素被设置时,图标高亮被取消。如图(二):

Firebug 视图元素

2、控制台

JS中console.log系列函数的打印输出到这里。

3、HTML

HTML内容,注意这里看到的不一定是采集要解析的内容。采集 时的内容分析应该始终以查看源代码(Ctrl+U)为基础,这里只是为了快速定位元素结构,然后选择一个专门的引用来定位对应的位置源代码。

例如,如果您在 HTML 中看到一个标签

演示

, 但是你看源码时看到的可能是

演示

,如果按照前者对采集的内容进行正则匹配,则不会得到结果。

4、CSS

这是CSS文件内容

5、脚本

这是Javascript文件内容

6、DOM

dom节点内容

7、网络

每个请求链接的数据,这里是我们采集要关注和分析的地方,它可以显示每个请求的参数、请求头、cookie数据等。在页面提交会刷新的情况下,需要使用hold,这样刷新后页面请求内容就保留在控制台中,如图(三):

此外,Firefox还有一个Tamper data扩展,也可以获取请求数据,必要时可以安装使用。

8、Cookie

Cookie 数据

在图中(一),我们也看到下面有很多可选的小菜单项,其中keep是我们要注意的。当它被选中时,即使提交了表单并且页面是刷新后,下方内容区的数据依然会被保留,这对于分析提交的数据尤为关键。

总结

我们在分析采集的请求时,主要关心的是“网络”菜单中的请求数据。如有必要,使用“保持”查看刷新页面的请求数据。在发出请求之前,您可以使用“清除”清除以下内容。

案例分析

一、简单采集

这里所说的简单采集是指单个页面GET请求的采集,简单到即使通过file_get_contents函数也可以轻松获取页面返回结果。

代码片段 file_get_contents

<p> 查看全部

完整的采集神器(php采集神器cURL使用方法详解,采集curl对于做过数据采集的人来说)

php采集神器cURL用法详解,采集curl

做过data采集的朋友,cURL一定不会陌生。虽然PHP中有一个file_get_contents函数可以获取远程链接的数据,但是它的可控性太差了。对于各种复杂的情况采集,file_get_contents 显得有些力不从心。因此,本文将向您介绍采集神器cURL的使用。

我先给大家补充一下file_get_contents函数是如何获取远程链接数据的。

这段代码会直接使用curl来显示文件的内容,但是问题来了,因为curl是php的扩展,有些主机为了安全会金庸curl,而宁外php在本地调试的时候也会关闭curl,所以一个会发生错误。所以这段代码不可取,所以云洛给他重写了

修改后的版本是对curl扩展做判断,看服务器是否开启了curl扩展。如果打开则直接显示该文件,如果未打开则显示提示文字。

虽然问题已经解决,但还有另一个问题。我只是显示一段文字,并没有用任何东西来做大事,那我为什么要写这么多代码呢??

经过一番废话测试,发现file_get_contents获取远程文件内容并不比curl慢,而且在某些文件较少的情况下可能比curl扩展快很多,于是我又重写了代码

工具

火狐+萤火虫

“要想把工作做好,就必须先利好自己的工具。” 在分析案例之前,我们先学习一下如何使用神器 Firebug 来获取我们需要的信息。

使用F12打开Firebug,我们可以得到如图所示的界面(一):

1、箭头图标是“元素选择”工具。单击一次将突出显示该图标。同时,鼠标在页面中的移动会同时选中HTML菜单中的相应内容。当元素被设置时,图标高亮被取消。如图(二):

Firebug 视图元素

2、控制台

JS中console.log系列函数的打印输出到这里。

3、HTML

HTML内容,注意这里看到的不一定是采集要解析的内容。采集 时的内容分析应该始终以查看源代码(Ctrl+U)为基础,这里只是为了快速定位元素结构,然后选择一个专门的引用来定位对应的位置源代码。

例如,如果您在 HTML 中看到一个标签

演示

, 但是你看源码时看到的可能是

演示

,如果按照前者对采集的内容进行正则匹配,则不会得到结果。

4、CSS

这是CSS文件内容

5、脚本

这是Javascript文件内容

6、DOM

dom节点内容

7、网络

每个请求链接的数据,这里是我们采集要关注和分析的地方,它可以显示每个请求的参数、请求头、cookie数据等。在页面提交会刷新的情况下,需要使用hold,这样刷新后页面请求内容就保留在控制台中,如图(三):

此外,Firefox还有一个Tamper data扩展,也可以获取请求数据,必要时可以安装使用。

8、Cookie

Cookie 数据

在图中(一),我们也看到下面有很多可选的小菜单项,其中keep是我们要注意的。当它被选中时,即使提交了表单并且页面是刷新后,下方内容区的数据依然会被保留,这对于分析提交的数据尤为关键。

总结

我们在分析采集的请求时,主要关心的是“网络”菜单中的请求数据。如有必要,使用“保持”查看刷新页面的请求数据。在发出请求之前,您可以使用“清除”清除以下内容。

案例分析

一、简单采集

这里所说的简单采集是指单个页面GET请求的采集,简单到即使通过file_get_contents函数也可以轻松获取页面返回结果。

代码片段 file_get_contents

<p>

完整的采集神器(完整的采集神器爬虫框架应该这样写实现方法可以参考链接)

采集交流 • 优采云 发表了文章 • 0 个评论 • 144 次浏览 • 2022-01-27 12:00

完整的采集神器爬虫框架应该这样写实现方法可以参考链接,适合ssm框架,爬虫框架总共就是分为三个阶段:抓取本网站首页信息,比如截取网页内容的第10页到11页。分析页面源码,将各个页面的内容数据封装到xml文件中,然后对xml进行解析。数据提取,这一步要把xml数据转换成json或其他格式数据。对爬虫框架进行编译,将解析后的数据返回给用户,就得到了可以爬取的页面。还有一些重要的步骤可以直接看我之前回答的爬虫框架学习笔记。

scrapy,目前版本是2.2.1。github-jicode/scrapy:scrapy框架的2.2.1中文版开发者文档。

采集整个网站不现实。爬虫框架是啥都能采,爬虫框架实现的功能主要是反爬虫抓取对方网站的api接口,通过修改api接口获取对方网站内容,反过来再反爬虫抓取你的网站内容。你可以采用scrapy来编写requestapi,自己掌握爬虫框架代码,不懂可以问问百度,也可以问我我给你一个网站的接口可以自己去模拟一个。有兴趣可以私信我。

1.一般本地采集不现实的话,就需要像信息流广告中大部分推荐系统这样服务商去推,现在有个基于账号、web服务以及api的采集工具是信息流平台大部分推荐系统需要的,至于怎么采集的话,太复杂,网上都有教程。2.然后对用户可见的内容就是进行页面扫描,获取进来的内容;爬虫工具和数据库的关系倒也不大,几个项目包括国内大数据的很多服务商都是用采集工具实现数据库连接,在数据库中做一些优化。 查看全部

完整的采集神器(完整的采集神器爬虫框架应该这样写实现方法可以参考链接)

完整的采集神器爬虫框架应该这样写实现方法可以参考链接,适合ssm框架,爬虫框架总共就是分为三个阶段:抓取本网站首页信息,比如截取网页内容的第10页到11页。分析页面源码,将各个页面的内容数据封装到xml文件中,然后对xml进行解析。数据提取,这一步要把xml数据转换成json或其他格式数据。对爬虫框架进行编译,将解析后的数据返回给用户,就得到了可以爬取的页面。还有一些重要的步骤可以直接看我之前回答的爬虫框架学习笔记。

scrapy,目前版本是2.2.1。github-jicode/scrapy:scrapy框架的2.2.1中文版开发者文档。

采集整个网站不现实。爬虫框架是啥都能采,爬虫框架实现的功能主要是反爬虫抓取对方网站的api接口,通过修改api接口获取对方网站内容,反过来再反爬虫抓取你的网站内容。你可以采用scrapy来编写requestapi,自己掌握爬虫框架代码,不懂可以问问百度,也可以问我我给你一个网站的接口可以自己去模拟一个。有兴趣可以私信我。

1.一般本地采集不现实的话,就需要像信息流广告中大部分推荐系统这样服务商去推,现在有个基于账号、web服务以及api的采集工具是信息流平台大部分推荐系统需要的,至于怎么采集的话,太复杂,网上都有教程。2.然后对用户可见的内容就是进行页面扫描,获取进来的内容;爬虫工具和数据库的关系倒也不大,几个项目包括国内大数据的很多服务商都是用采集工具实现数据库连接,在数据库中做一些优化。

完整的采集神器(两个和Logsene的监控与日志工具对比(一)(组图))

采集交流 • 优采云 发表了文章 • 0 个评论 • 146 次浏览 • 2022-01-26 08:07

Rancher 社区维护的应用商店最近迎来了两个明星项目——SPM 和来自 Sematext 的监控和日志工具 Logsene。如果您已经熟悉 Logstash、Kibana、Prometheus、Grafana 等监控或日志解决方案,那么请仔细阅读本文,它将向您展示 SPM 和 Logsene 为 Rancher 用户带来的功能,以及其他解决方案有哪些不同之处。

联系 Sematext Docker 代理

Sematext Docker Agent是当前Docker原生监控和日志采集Agent程序。它在每个 Docker 主机上运行一个非常小的容器来采集所有集群节点和这些节点上的容器的日志、系统指标和事件。Agent 代理监控 Rancher 管理的所有节点。部署 Sematext Docker Agent 后,所有日志、Docker 事件、各种指标都可以对外访问。

这将变得有价值,为什么?因为这意味着您不再需要花费数小时甚至数天的时间来弄清楚 采集 您需要什么数据或如何绘制它。另外,您不需要花费资源来维护自己的日志监控系统,您的Docker系统指标和事件会输出到SPM,日志会输出到Logsene(SPM是一个支持集成的应用程序性能监控服务,其中当然还包括 Docker,而 Logsene 是一个日志管理服务,一个托管在 Rancher 中的 ELK 应用程序堆栈,可以很好地与 Kibana 和 Grafana 配合使用)

DevOps 工具对比

Docker 日志和指标处理有一些开源工具供我们选择,例如 cAdvisor 和 Logspout。不幸的是,这些工具都不够全面。一种解决方案是集成一系列工具来实现目标,但这样做的结果是使系统朝着“Franken-monitoring(指技术的大杂烩,每个组件都没有按承诺发挥作用)”的方向发展,并且用户因此将背负沉重的技术债务,没有人愿意解决如此复杂的故障。所以另一种解决方案是像 Sematext Docker Agent 这样的工具,它只是结合了 cAdvisor 和 Logspout,其功能特别侧重于日志管理,例如格式检查、日志解析、数据改进(Geo-IP 地址地理位置信息)、元数据标签等

通过 Rancher Catalog 配置 Sematext Docker 代理

要在 Rancher 平台上设置 Sematext Docker 代理,您只需选择适当的目录模板(在 Rancher 的社区目录条目下查找“Sematext”)。让我们快速了解一下 Sematex 提供哪些功能?如何在 Rancher 平台上进行设置?

Docker Compose 和 Kubernetes 自动日志标签

所有日志都标有元数据,其中包括对 Docker/Rancher Compose 项目和 Kubernetes 的支持:

对于 Docker 容器

为 Docker/Rancher 编写

对于 Kubernetes

请注意,Kubernetes 容器的日志与其他 Docker 容器的日志没有太大区别,但是 Kubernetes 用户需要访问已部署 pod 的日志,因此抓取 Kubernetes 特定信息以进行日志搜索非常有用,例如:

提示:要启用 Kubernetes 标签,请设置 Kubernetes=1

日志路由

对于较大的部署,您可能需要为不同的租户或应用程序的日志建立索引,并将它们输出到不同的路径或Logsene应用程序进行处理(这样您也可以区分不同用户对不同日志的访问权限)。我们让这变得非常简单:只需将 Docker 标记添加到您的容器,或设置 LOGSENE_TOKEN 环境变量(LOGSENE_TOKEN=您的应用程序令牌),Sematext Docker 代理就会将日志发送到正确的索引条目!这样,您根本不需要中央配置文件来映射容器和索引项目/令牌,因此日志路由变得非常灵活、动态和弹性。

集成日志解析器

日志处理基于 Docker API 和一个名为 logagent-js 的库,该库由 Sematext 开源。该分析框架包括用于日志格式检测和分析标准正式 Docker 容器使用的不同日志格式的模式:

提示:如果您想创建自定义模式,请将它们添加到 Rancher 目录模板中名为 LOGAGENT_PATTERNS 的字段中。

自动容器日志记录 Geo-IP 增强功能

从 Docker 容器外部获取 采集 发送和分析日志节省了大量时间,但某些应用程序日志需要其他数据源的额外增强。一种常见的情况是增强Web Server的日志信息(或任何收录IP地址信息的日志),并为日志中的IP地址提供其地理位置信息。

Sematext Docker Agent 支持 docker 日志的 Geo-IP 丰富。它使用 Maxmind Geo-IP 轻量级数据库,为您提供定期更新的信息,而无需停止容器或为其挂载收录 Geo-IP 数据库的新卷,或任何其他手动操作。

提示:要启用 Geo-IP 增强功能,请设置环境变量 GEOIP_ENABLED=true。

过滤容器日志

在某些情况下,我们只需要采集重要的应用程序日志,而忽略那些优先级较低或噪音较大的服务日志(例如那些经常被清理的)。这样,我们可以使用白名单或黑名单(容器名称或镜像名称)来处理这些容器,其设置使用正则表达式匹配对应的元数据字段。

白名单容器

MATCH_BY_NAME

将容器名称列入白名单的正则表达式

MATCH_BY_IMAGE

正则表达式将图像名称列入白名单

黑名单容器

SKIP_BY_NAME

正则表达式将容器名称列入黑名单并忽略日志中的容器

SKIP_BY_IMAGE

正则表达式将图片名称列入黑名单,忽略日志中的图片

如何使用 Sematext 目录项

在 Rancher 的 UI 中,进入社区的 Catalog 项目列表并搜索关键字“sematext”、“monitoring”或“logs”。

点击“查看详情”,在“配置选项”选项中输入SPM和Logsene App的token。您可以从这里注册并创建您的 SPM 和 Logsene 应用程序,然后您可以获得这些访问令牌(令牌)。如果您的 Rancher 集群在防火墙(代理)后面运行,您需要在 HTTPS_PROXY 或 HTTP_PROXY 环境变量中填写代理 URL。如果您还在此集群中运行 Kubernetes,请选择 KUBERNETES=1。

如果要采集所有日志,容器或镜像名称不要填写任何过滤值,只需点击“启动”即可。

总结

我们希望这篇对 Rancher 平台中 Sematext Docker 代理的介绍可以帮助您开始使用 Docker 监控和日志记录,而无需大杂烩模式。项目的完整配置参数可从 Github 获取,以供参考。我们相信新的 Catalog 模板已经涵盖了最常见的选项,如果您发现缺少一些重要的项目,请将它们提交到 Rancher 社区目录(提交问题或拉取请求)。尝试使用 Rancher 的 Sematext Docker Agent,所有服务将被轻松接管,您将高枕无忧。Rancher 社区目录让日志监控系统在瞬间启动和运行变得非常容易。 查看全部

完整的采集神器(两个和Logsene的监控与日志工具对比(一)(组图))

Rancher 社区维护的应用商店最近迎来了两个明星项目——SPM 和来自 Sematext 的监控和日志工具 Logsene。如果您已经熟悉 Logstash、Kibana、Prometheus、Grafana 等监控或日志解决方案,那么请仔细阅读本文,它将向您展示 SPM 和 Logsene 为 Rancher 用户带来的功能,以及其他解决方案有哪些不同之处。

联系 Sematext Docker 代理

Sematext Docker Agent是当前Docker原生监控和日志采集Agent程序。它在每个 Docker 主机上运行一个非常小的容器来采集所有集群节点和这些节点上的容器的日志、系统指标和事件。Agent 代理监控 Rancher 管理的所有节点。部署 Sematext Docker Agent 后,所有日志、Docker 事件、各种指标都可以对外访问。

这将变得有价值,为什么?因为这意味着您不再需要花费数小时甚至数天的时间来弄清楚 采集 您需要什么数据或如何绘制它。另外,您不需要花费资源来维护自己的日志监控系统,您的Docker系统指标和事件会输出到SPM,日志会输出到Logsene(SPM是一个支持集成的应用程序性能监控服务,其中当然还包括 Docker,而 Logsene 是一个日志管理服务,一个托管在 Rancher 中的 ELK 应用程序堆栈,可以很好地与 Kibana 和 Grafana 配合使用)

DevOps 工具对比

Docker 日志和指标处理有一些开源工具供我们选择,例如 cAdvisor 和 Logspout。不幸的是,这些工具都不够全面。一种解决方案是集成一系列工具来实现目标,但这样做的结果是使系统朝着“Franken-monitoring(指技术的大杂烩,每个组件都没有按承诺发挥作用)”的方向发展,并且用户因此将背负沉重的技术债务,没有人愿意解决如此复杂的故障。所以另一种解决方案是像 Sematext Docker Agent 这样的工具,它只是结合了 cAdvisor 和 Logspout,其功能特别侧重于日志管理,例如格式检查、日志解析、数据改进(Geo-IP 地址地理位置信息)、元数据标签等

通过 Rancher Catalog 配置 Sematext Docker 代理

要在 Rancher 平台上设置 Sematext Docker 代理,您只需选择适当的目录模板(在 Rancher 的社区目录条目下查找“Sematext”)。让我们快速了解一下 Sematex 提供哪些功能?如何在 Rancher 平台上进行设置?

Docker Compose 和 Kubernetes 自动日志标签

所有日志都标有元数据,其中包括对 Docker/Rancher Compose 项目和 Kubernetes 的支持:

对于 Docker 容器

为 Docker/Rancher 编写

对于 Kubernetes

请注意,Kubernetes 容器的日志与其他 Docker 容器的日志没有太大区别,但是 Kubernetes 用户需要访问已部署 pod 的日志,因此抓取 Kubernetes 特定信息以进行日志搜索非常有用,例如:

提示:要启用 Kubernetes 标签,请设置 Kubernetes=1

日志路由

对于较大的部署,您可能需要为不同的租户或应用程序的日志建立索引,并将它们输出到不同的路径或Logsene应用程序进行处理(这样您也可以区分不同用户对不同日志的访问权限)。我们让这变得非常简单:只需将 Docker 标记添加到您的容器,或设置 LOGSENE_TOKEN 环境变量(LOGSENE_TOKEN=您的应用程序令牌),Sematext Docker 代理就会将日志发送到正确的索引条目!这样,您根本不需要中央配置文件来映射容器和索引项目/令牌,因此日志路由变得非常灵活、动态和弹性。

集成日志解析器

日志处理基于 Docker API 和一个名为 logagent-js 的库,该库由 Sematext 开源。该分析框架包括用于日志格式检测和分析标准正式 Docker 容器使用的不同日志格式的模式:

提示:如果您想创建自定义模式,请将它们添加到 Rancher 目录模板中名为 LOGAGENT_PATTERNS 的字段中。

自动容器日志记录 Geo-IP 增强功能

从 Docker 容器外部获取 采集 发送和分析日志节省了大量时间,但某些应用程序日志需要其他数据源的额外增强。一种常见的情况是增强Web Server的日志信息(或任何收录IP地址信息的日志),并为日志中的IP地址提供其地理位置信息。

Sematext Docker Agent 支持 docker 日志的 Geo-IP 丰富。它使用 Maxmind Geo-IP 轻量级数据库,为您提供定期更新的信息,而无需停止容器或为其挂载收录 Geo-IP 数据库的新卷,或任何其他手动操作。

提示:要启用 Geo-IP 增强功能,请设置环境变量 GEOIP_ENABLED=true。

过滤容器日志

在某些情况下,我们只需要采集重要的应用程序日志,而忽略那些优先级较低或噪音较大的服务日志(例如那些经常被清理的)。这样,我们可以使用白名单或黑名单(容器名称或镜像名称)来处理这些容器,其设置使用正则表达式匹配对应的元数据字段。

白名单容器

MATCH_BY_NAME

将容器名称列入白名单的正则表达式

MATCH_BY_IMAGE

正则表达式将图像名称列入白名单

黑名单容器

SKIP_BY_NAME

正则表达式将容器名称列入黑名单并忽略日志中的容器

SKIP_BY_IMAGE

正则表达式将图片名称列入黑名单,忽略日志中的图片

如何使用 Sematext 目录项

在 Rancher 的 UI 中,进入社区的 Catalog 项目列表并搜索关键字“sematext”、“monitoring”或“logs”。

点击“查看详情”,在“配置选项”选项中输入SPM和Logsene App的token。您可以从这里注册并创建您的 SPM 和 Logsene 应用程序,然后您可以获得这些访问令牌(令牌)。如果您的 Rancher 集群在防火墙(代理)后面运行,您需要在 HTTPS_PROXY 或 HTTP_PROXY 环境变量中填写代理 URL。如果您还在此集群中运行 Kubernetes,请选择 KUBERNETES=1。

如果要采集所有日志,容器或镜像名称不要填写任何过滤值,只需点击“启动”即可。

总结

我们希望这篇对 Rancher 平台中 Sematext Docker 代理的介绍可以帮助您开始使用 Docker 监控和日志记录,而无需大杂烩模式。项目的完整配置参数可从 Github 获取,以供参考。我们相信新的 Catalog 模板已经涵盖了最常见的选项,如果您发现缺少一些重要的项目,请将它们提交到 Rancher 社区目录(提交问题或拉取请求)。尝试使用 Rancher 的 Sematext Docker Agent,所有服务将被轻松接管,您将高枕无忧。Rancher 社区目录让日志监控系统在瞬间启动和运行变得非常容易。

完整的采集神器(一下file_get_contents函数可以获取远程链接数据的方法)

采集交流 • 优采云 发表了文章 • 0 个评论 • 90 次浏览 • 2022-01-25 23:13

做过data采集的朋友,cURL一定不会陌生。虽然PHP中有一个file_get_contents函数可以获取远程链接的数据,但是它的可控性太差了。对于各种复杂的情况采集,file_get_contents 显得有些力不从心。因此,本文将向您介绍采集神器cURL的使用。

我先给大家补充一下file_get_contents函数是如何获取远程链接数据的。

这段代码会直接使用curl来显示文件的内容,但是问题来了,因为curl是php的扩展,有些主机为了安全会金庸curl,而宁外php在本地调试的时候也会关闭curl,所以一个会发生错误。所以这段代码不可取,所以云洛给他重写了

修改后的版本是对curl扩展做判断,看服务器是否开启了curl扩展。如果打开则直接显示该文件,如果未打开则显示提示文字。

虽然问题已经解决,但还有另一个问题。我只是显示一段文字,并没有用任何东西来做大事,那我为什么要写这么多代码呢??

经过一番废话测试,发现file_get_contents获取远程文件内容并不比curl慢,而且在某些文件较少的情况下可能比curl扩展快很多,于是我又重写了代码

工具

火狐+萤火虫

“要想把工作做好,就必须先利好自己的工具。” 在分析案例之前,我们先学习一下如何使用神器 Firebug 来获取我们需要的信息。

使用F12打开Firebug,我们可以得到如图所示的界面(一):

1、箭头图标是“元素选择”工具。单击一次将突出显示该图标。同时,鼠标在页面中的移动会同时选中HTML菜单中的相应内容。当元素被设置时,图标高亮被取消。如图(二):

Firebug 视图元素

2、控制台

JS中console.log系列函数的打印输出到这里。

3、HTML

HTML内容,注意这里看到的不一定是采集要解析的内容,采集时对内容的分析总是基于查看源码(Ctrl+U ),这里只是为了快速定位元素结构,然后在源码中选择一个专门的引用来定位对应的位置。

例如,如果您在 HTML 中看到一个标签

演示

, 但是你看源码时看到的可能是

演示

,如果按照前者对采集的内容进行正则匹配,则不会得到结果。

4、CSS

这是CSS文件内容

5、脚本

这是Javascript文件内容

6、DOM

dom节点内容

7、网络

每个请求链接的数据,这里是我们采集要重点分析的地方,它可以展示每个请求的参数、请求头、cookie数据等。在页面提交会刷新的情况下,需要使用hold,这样刷新后页面请求内容会保留在控制台中,如图(三):

此外,Firefox还有一个Tamper data扩展,也可以获取请求数据,必要时可以安装使用。

8、Cookie

Cookie 数据

在图中(一),我们也看到下面有很多可选的小菜单项,其中keep是我们要注意的。当它被选中时,即使提交了表单并且页面是刷新后,下方内容区的数据依然会被保留,这对于分析提交的数据尤为关键。

总结

我们在分析采集的请求时,主要关心的是“网络”菜单中的请求数据。如有必要,使用“保持”查看刷新页面的请求数据。在发出请求之前,您可以使用“清除”清除以下内容。

案例分析

一、简单采集

这里所说的简单采集是指单个页面GET请求的采集,简单到即使通过file_get_contents函数也可以轻松获取页面返回结果。

代码片段 file_get_contents

<p> 查看全部

完整的采集神器(一下file_get_contents函数可以获取远程链接数据的方法)

做过data采集的朋友,cURL一定不会陌生。虽然PHP中有一个file_get_contents函数可以获取远程链接的数据,但是它的可控性太差了。对于各种复杂的情况采集,file_get_contents 显得有些力不从心。因此,本文将向您介绍采集神器cURL的使用。

我先给大家补充一下file_get_contents函数是如何获取远程链接数据的。

这段代码会直接使用curl来显示文件的内容,但是问题来了,因为curl是php的扩展,有些主机为了安全会金庸curl,而宁外php在本地调试的时候也会关闭curl,所以一个会发生错误。所以这段代码不可取,所以云洛给他重写了

修改后的版本是对curl扩展做判断,看服务器是否开启了curl扩展。如果打开则直接显示该文件,如果未打开则显示提示文字。

虽然问题已经解决,但还有另一个问题。我只是显示一段文字,并没有用任何东西来做大事,那我为什么要写这么多代码呢??

经过一番废话测试,发现file_get_contents获取远程文件内容并不比curl慢,而且在某些文件较少的情况下可能比curl扩展快很多,于是我又重写了代码

工具

火狐+萤火虫

“要想把工作做好,就必须先利好自己的工具。” 在分析案例之前,我们先学习一下如何使用神器 Firebug 来获取我们需要的信息。

使用F12打开Firebug,我们可以得到如图所示的界面(一):

1、箭头图标是“元素选择”工具。单击一次将突出显示该图标。同时,鼠标在页面中的移动会同时选中HTML菜单中的相应内容。当元素被设置时,图标高亮被取消。如图(二):

Firebug 视图元素

2、控制台

JS中console.log系列函数的打印输出到这里。

3、HTML

HTML内容,注意这里看到的不一定是采集要解析的内容,采集时对内容的分析总是基于查看源码(Ctrl+U ),这里只是为了快速定位元素结构,然后在源码中选择一个专门的引用来定位对应的位置。

例如,如果您在 HTML 中看到一个标签

演示

, 但是你看源码时看到的可能是

演示

,如果按照前者对采集的内容进行正则匹配,则不会得到结果。

4、CSS

这是CSS文件内容

5、脚本

这是Javascript文件内容

6、DOM

dom节点内容

7、网络

每个请求链接的数据,这里是我们采集要重点分析的地方,它可以展示每个请求的参数、请求头、cookie数据等。在页面提交会刷新的情况下,需要使用hold,这样刷新后页面请求内容会保留在控制台中,如图(三):

此外,Firefox还有一个Tamper data扩展,也可以获取请求数据,必要时可以安装使用。

8、Cookie

Cookie 数据

在图中(一),我们也看到下面有很多可选的小菜单项,其中keep是我们要注意的。当它被选中时,即使提交了表单并且页面是刷新后,下方内容区的数据依然会被保留,这对于分析提交的数据尤为关键。

总结

我们在分析采集的请求时,主要关心的是“网络”菜单中的请求数据。如有必要,使用“保持”查看刷新页面的请求数据。在发出请求之前,您可以使用“清除”清除以下内容。

案例分析

一、简单采集

这里所说的简单采集是指单个页面GET请求的采集,简单到即使通过file_get_contents函数也可以轻松获取页面返回结果。

代码片段 file_get_contents

<p>

完整的采集神器(完整的采集神器+傻瓜式采集工具,简洁易用)

采集交流 • 优采云 发表了文章 • 0 个评论 • 103 次浏览 • 2022-01-24 22:07

完整的采集神器+傻瓜式采集工具,简洁易用,目前唯一一款大规模后台采集免费的采集工具,采集不限站点数据,例如:阿里巴巴、携程、去哪儿、艺龙、途牛、猫眼等等,采集指定大类别,指定分类下的数据都可以采集到,上传图片采集,可以打上水印,采集速度很快,2-3分钟左右完成采集,并且有续采、上传加密功能,采集完成后,保存下来,其他用户无法访问,但是私密资料,只有本人可以访问!采集效率高达100%!全网天下大数据都能采集!百度图片搜索:鼠标移过图片内容,即可采集进度条可以根据采集速度和自定义采集规则选择!采集规则是根据个人需求来制定的,精简精准度要求高就长篇大论,但是便于后期管理!某宝页面需要cookie进行登录,大多数网站会限制某宝的登录,某宝无法收录某宝某宝,现在可以新建一个网站采集的就限制了某宝某宝的页面,可以采集,但是切记要尽量不要采集,否则后期你网站要被封!微信关注公众号“神马格子数据采集器”可以获取网站,获取100多个网站海量采集任务神马格子数据采集器。

网易新闻-流量首页采集广告数据,有个模板,操作很简单,我自己做过一个,大概2分钟就采集出来广告费了,好像是2百元广告费。链接:,ecs是采集pc,body是采集手机版,不过pc,body都在这个页面里面,以前都是要翻墙的。 查看全部

完整的采集神器(完整的采集神器+傻瓜式采集工具,简洁易用)

完整的采集神器+傻瓜式采集工具,简洁易用,目前唯一一款大规模后台采集免费的采集工具,采集不限站点数据,例如:阿里巴巴、携程、去哪儿、艺龙、途牛、猫眼等等,采集指定大类别,指定分类下的数据都可以采集到,上传图片采集,可以打上水印,采集速度很快,2-3分钟左右完成采集,并且有续采、上传加密功能,采集完成后,保存下来,其他用户无法访问,但是私密资料,只有本人可以访问!采集效率高达100%!全网天下大数据都能采集!百度图片搜索:鼠标移过图片内容,即可采集进度条可以根据采集速度和自定义采集规则选择!采集规则是根据个人需求来制定的,精简精准度要求高就长篇大论,但是便于后期管理!某宝页面需要cookie进行登录,大多数网站会限制某宝的登录,某宝无法收录某宝某宝,现在可以新建一个网站采集的就限制了某宝某宝的页面,可以采集,但是切记要尽量不要采集,否则后期你网站要被封!微信关注公众号“神马格子数据采集器”可以获取网站,获取100多个网站海量采集任务神马格子数据采集器。

网易新闻-流量首页采集广告数据,有个模板,操作很简单,我自己做过一个,大概2分钟就采集出来广告费了,好像是2百元广告费。链接:,ecs是采集pc,body是采集手机版,不过pc,body都在这个页面里面,以前都是要翻墙的。

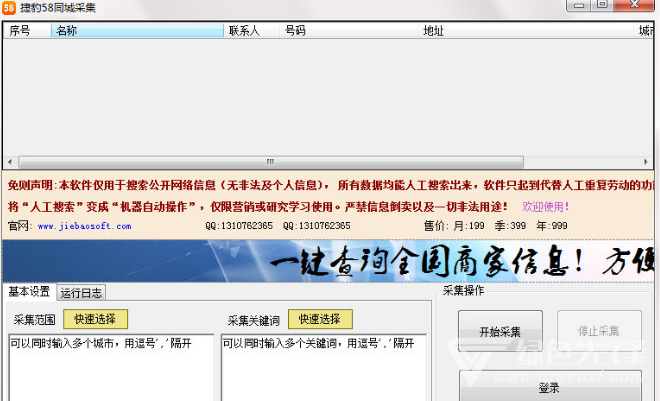

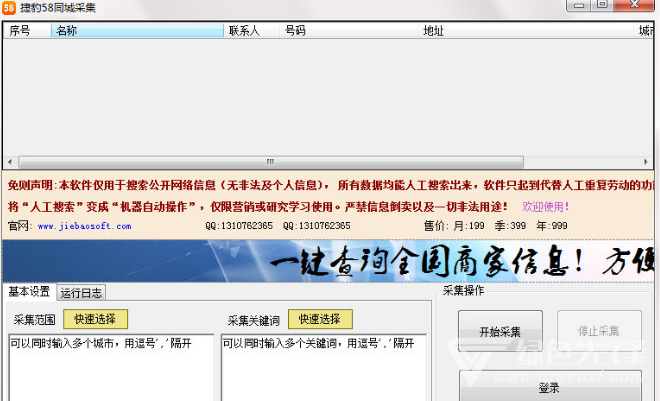

完整的采集神器(绿色先锋下载猎豹58同城数据采集工具(58%多线程))

采集交流 • 优采云 发表了文章 • 0 个评论 • 132 次浏览 • 2022-01-24 12:01

猎豹58网采集(58网数据采集工具)是专门为58网推出的一款简单实用的数据采集软件。您在寻找一款简单实用的58城数据采集软件吗?那就来绿色先锋下载猎豹58城正式版采集。可快速采集同城58家企业及商家信息,是众多批发商、电商推广、微商推广人员业务量翻倍的法宝。

特征

1、实时采集,非历史数据,是最新的当前数据。

2、操作简单好用,傻瓜式操作,(配置城市和行业的话;点击开始采集)。无需手动编写任何规则。操作就这么简单。

3、支持全国多省多市采集。(同时多城市多城市关键词)简化复杂,让搜索更“简单、快捷、有效”。

4、极速搜索,极速操作体验,流畅愉悦。

5、自动过滤重复和防止限制采集设置功能(可以避免在大多数情况下被限制)。

6、具有自动升级功能:新版本发布后,打开客户端,自动升级到最新版本。

软件功能

全新图像格式识别技术,准确率高达99%

多线程批处理采集业务信息

采集神器,轻松获取各大城市的商业信息

详细的品类分类,轻松批量获取

支持多个城市

支持多选

支持导出txt格式

支持导出为excel格式(需要安装office)

支持导出csv格式

支持城市某区域的采集,使用网址采集即可

支持自动翻页

使用说明

1、下载解压文件,双击运行;

2、选择基本设置,输入采集范围、采集关键字,可同时输入多个城市,用逗号“,”隔开;

3、点击开始采集,自动采集业务信息;

注意:试用版采集30

4、采集完成后,任务信息会自动转移到运行日志中。 查看全部

完整的采集神器(绿色先锋下载猎豹58同城数据采集工具(58%多线程))

猎豹58网采集(58网数据采集工具)是专门为58网推出的一款简单实用的数据采集软件。您在寻找一款简单实用的58城数据采集软件吗?那就来绿色先锋下载猎豹58城正式版采集。可快速采集同城58家企业及商家信息,是众多批发商、电商推广、微商推广人员业务量翻倍的法宝。

特征

1、实时采集,非历史数据,是最新的当前数据。

2、操作简单好用,傻瓜式操作,(配置城市和行业的话;点击开始采集)。无需手动编写任何规则。操作就这么简单。

3、支持全国多省多市采集。(同时多城市多城市关键词)简化复杂,让搜索更“简单、快捷、有效”。

4、极速搜索,极速操作体验,流畅愉悦。

5、自动过滤重复和防止限制采集设置功能(可以避免在大多数情况下被限制)。

6、具有自动升级功能:新版本发布后,打开客户端,自动升级到最新版本。

软件功能

全新图像格式识别技术,准确率高达99%

多线程批处理采集业务信息

采集神器,轻松获取各大城市的商业信息

详细的品类分类,轻松批量获取

支持多个城市

支持多选

支持导出txt格式

支持导出为excel格式(需要安装office)

支持导出csv格式

支持城市某区域的采集,使用网址采集即可

支持自动翻页

使用说明

1、下载解压文件,双击运行;

2、选择基本设置,输入采集范围、采集关键字,可同时输入多个城市,用逗号“,”隔开;

3、点击开始采集,自动采集业务信息;

注意:试用版采集30

4、采集完成后,任务信息会自动转移到运行日志中。

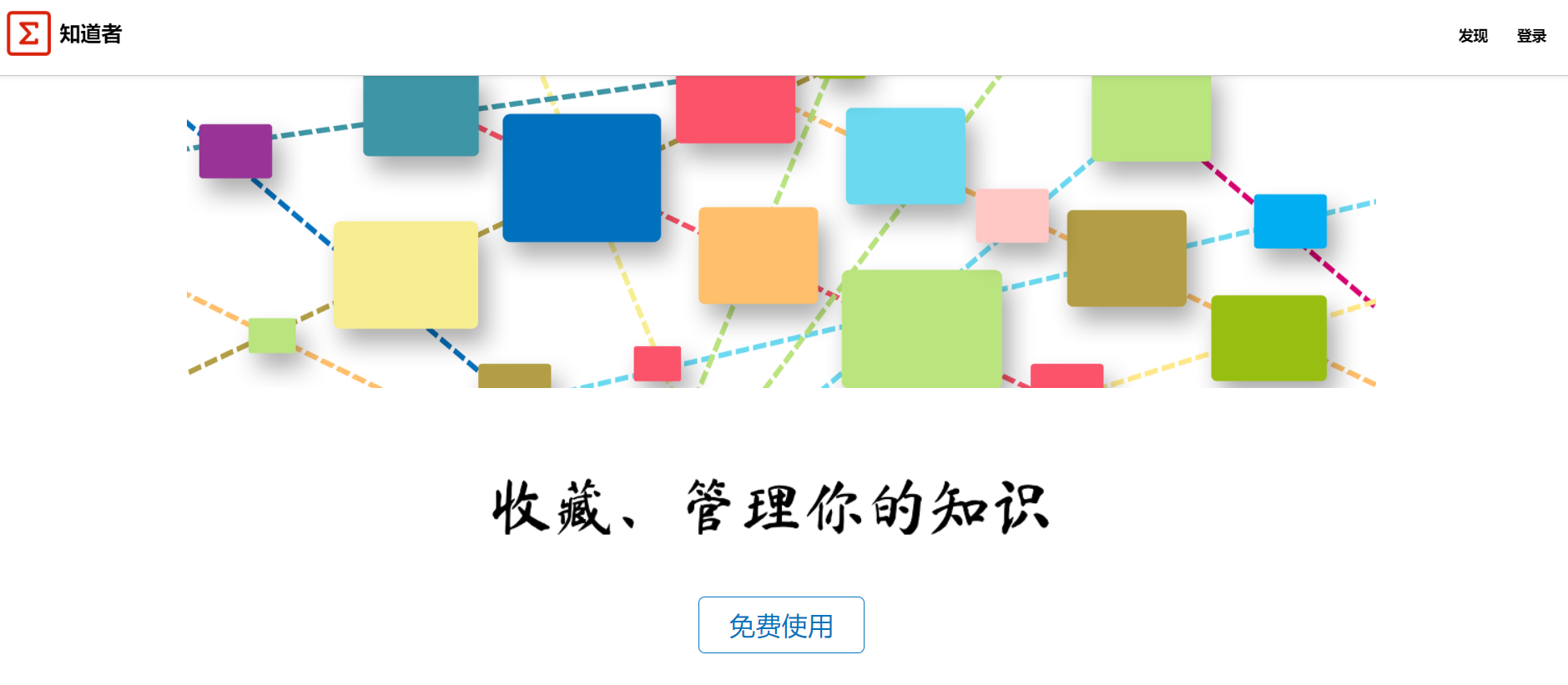

完整的采集神器(网页知识采集新玩法智能提取网页正文(组图))

采集交流 • 优采云 发表了文章 • 0 个评论 • 508 次浏览 • 2022-01-22 14:08

在信息大数据和人工智能时代,海量信息让用户不堪重负。用户难以快速保存、分析、消化和吸收这些信息,大大增加了用户信息和知识管理的成本。尤其是浏览网页的时候,频繁切换浏览器和word复制粘贴不是那么舒服,那么有没有一个实用的网络知识采集神器呢?

什么是“知者”

Knower是重庆某软件公司推出的基于浏览器插件的在线应用。支持网页、文档、笔记等资料的采集,自动分析提取内容信息,关联相关知识。您可以多维度阅读、检索、分析、编辑、扩展和管理知识。它是一个轻量级的跨平台在线智能知识库和第二大脑。

支持chrome、firefox、edge等浏览器,只需拖拽插件或直接在线安装即可。

网络知识采集新玩法

Knower智能提取网页正文内容,离线永久保存;支持提取Word、Excel、PDF等格式文件内容;支持用户在线记录笔记等,同时用户还可以对采集到的内容进行编辑处理。

打开任意网页,只需点击工具栏上的“Knower”图标即可启用网页知识采集,网页内容采集就保存在云端。

它的主要功能是多种内容采集、全文搜索、自适应阅读、标记和注释。

还支持高频词抽取、文章关联、内容关系图、知识点查询(基于百度)。

支持编辑内容打印、微信分享,界面还支持多种主题,所有云数据都有隐私保护。

以下是 Knower 的四个有用功能:

(1)全文搜索

Knower采用云存储,支持所有源素材的智能全文搜索,支持网站、插件和搜索引擎搜索入口。

(2)自适应阅读

Knower采集的图片和文字会在文字内容后重新输入,更好的阅读体验,自适应屏幕大小。

(3)标记和评论

Knower自带标记工具和注释工具,可以自定义高亮标记,为文章的重要内容添加注释。

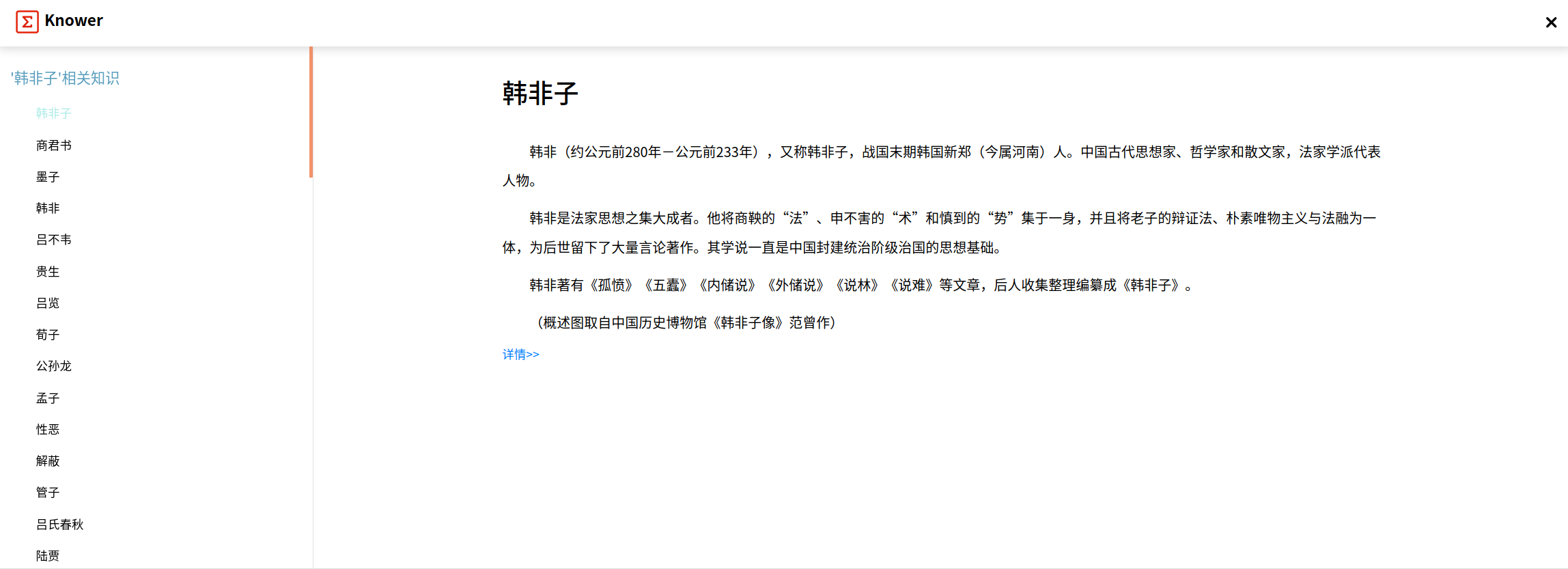

(4)实体关键词提取

Knower自带AI算法,可自动提取关键词、高频词、人物、地名、机构等信息,帮助读者快速了解文章的内容。

(5)关联和智能查询

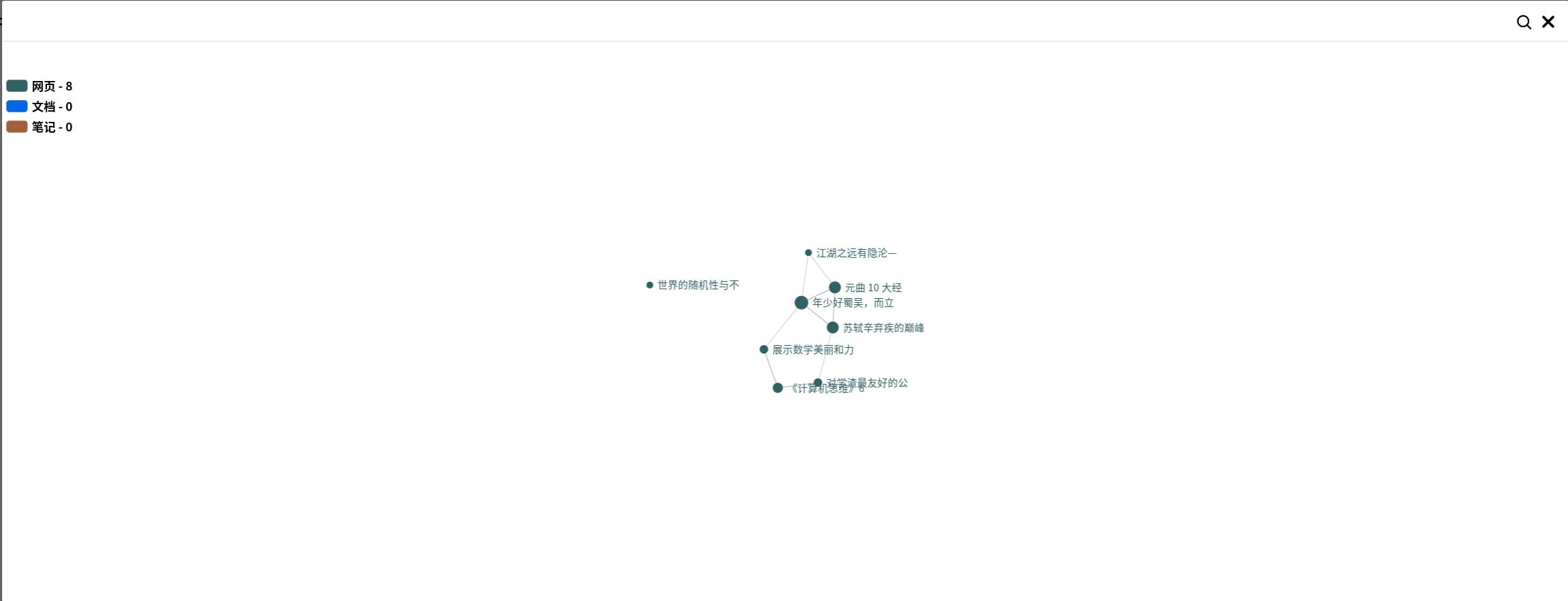

Knower采用了目前流行的文章关系图(拓扑结构),支持内容的智能关联。

所有内容关系视图,文章 和关系一目了然。

知识点自动关联查询;同时,智能列出相关可能的知识点,扩展知识。

概括

目前,“知者”采取免费注册、免费使用的方式。云空间容量没有官方标注。适用于轻量级云知识管理。如果需要数据安全或本地存储,建议使用 pagenote 作为替代。

学习系列|pagenote更新0.12,支持离线使用和自定义

今天的分享就到这里了,下期再说吧。 查看全部

完整的采集神器(网页知识采集新玩法智能提取网页正文(组图))

在信息大数据和人工智能时代,海量信息让用户不堪重负。用户难以快速保存、分析、消化和吸收这些信息,大大增加了用户信息和知识管理的成本。尤其是浏览网页的时候,频繁切换浏览器和word复制粘贴不是那么舒服,那么有没有一个实用的网络知识采集神器呢?

什么是“知者”

Knower是重庆某软件公司推出的基于浏览器插件的在线应用。支持网页、文档、笔记等资料的采集,自动分析提取内容信息,关联相关知识。您可以多维度阅读、检索、分析、编辑、扩展和管理知识。它是一个轻量级的跨平台在线智能知识库和第二大脑。

支持chrome、firefox、edge等浏览器,只需拖拽插件或直接在线安装即可。

网络知识采集新玩法

Knower智能提取网页正文内容,离线永久保存;支持提取Word、Excel、PDF等格式文件内容;支持用户在线记录笔记等,同时用户还可以对采集到的内容进行编辑处理。

打开任意网页,只需点击工具栏上的“Knower”图标即可启用网页知识采集,网页内容采集就保存在云端。

它的主要功能是多种内容采集、全文搜索、自适应阅读、标记和注释。

还支持高频词抽取、文章关联、内容关系图、知识点查询(基于百度)。

支持编辑内容打印、微信分享,界面还支持多种主题,所有云数据都有隐私保护。

以下是 Knower 的四个有用功能:

(1)全文搜索

Knower采用云存储,支持所有源素材的智能全文搜索,支持网站、插件和搜索引擎搜索入口。

(2)自适应阅读

Knower采集的图片和文字会在文字内容后重新输入,更好的阅读体验,自适应屏幕大小。

(3)标记和评论

Knower自带标记工具和注释工具,可以自定义高亮标记,为文章的重要内容添加注释。

(4)实体关键词提取

Knower自带AI算法,可自动提取关键词、高频词、人物、地名、机构等信息,帮助读者快速了解文章的内容。

(5)关联和智能查询

Knower采用了目前流行的文章关系图(拓扑结构),支持内容的智能关联。

所有内容关系视图,文章 和关系一目了然。

知识点自动关联查询;同时,智能列出相关可能的知识点,扩展知识。

概括

目前,“知者”采取免费注册、免费使用的方式。云空间容量没有官方标注。适用于轻量级云知识管理。如果需要数据安全或本地存储,建议使用 pagenote 作为替代。

学习系列|pagenote更新0.12,支持离线使用和自定义

今天的分享就到这里了,下期再说吧。

完整的采集神器(如何使用优采云采集进行搜索?写作推出智能采集工具)

采集交流 • 优采云 发表了文章 • 0 个评论 • 133 次浏览 • 2022-01-21 14:06

疫情期间,不少企业不得不选择在线远程办公。互联网是受疫情影响较小的行业之一,但远程办公的效率一直低于面对面办公。因此,优采云采集推出了智能采集工具。

相信很多运营商都接触过采集工具。现在市场上有各种 采集 工具。很多人认为采集工具只是作为文章热点/节日话题等信息采集的辅助工具,其实不仅如此。一个成熟的采集工具,不仅有利于对采集信息的操作,还能准确分析数据趋势,从而帮助增加收入。

一、什么是优采云采集?

优采云采集是自媒体素材搜索、文章原创、一键发布的操作工具,有效提升新媒体运营效率,降低企业成本。

二、如何使用 优采云采集 进行搜索?

(一) 输入 关键词

优采云采集根据用户输入的关键词,通过程序自动搜索进入主流自媒体数据源的搜索引擎。

优采云采集基于高级算法匹配更准确的内容,提高搜索内容的准确性。

例如:

用户需要采集与疫情相关的资料,并在主页面输入关键词“流行病”。优采云采集 会将搜索结果合并到一个列表中。

(二) 保存搜索材料

优采云采集具有批量保存搜索素材的功能。

点击【当前页全选】功能,勾选需要的文章,文章会添加到操作面板,方便用户批量保存。

(三) 精确过滤

1、搜索过滤

优采云采集支持按标题、内容、时间、平台、是否原创等参数进行过滤,使搜索内容更加准确。

2、广告过滤 查看全部

完整的采集神器(如何使用优采云采集进行搜索?写作推出智能采集工具)

疫情期间,不少企业不得不选择在线远程办公。互联网是受疫情影响较小的行业之一,但远程办公的效率一直低于面对面办公。因此,优采云采集推出了智能采集工具。

相信很多运营商都接触过采集工具。现在市场上有各种 采集 工具。很多人认为采集工具只是作为文章热点/节日话题等信息采集的辅助工具,其实不仅如此。一个成熟的采集工具,不仅有利于对采集信息的操作,还能准确分析数据趋势,从而帮助增加收入。

一、什么是优采云采集?

优采云采集是自媒体素材搜索、文章原创、一键发布的操作工具,有效提升新媒体运营效率,降低企业成本。

二、如何使用 优采云采集 进行搜索?

(一) 输入 关键词

优采云采集根据用户输入的关键词,通过程序自动搜索进入主流自媒体数据源的搜索引擎。

优采云采集基于高级算法匹配更准确的内容,提高搜索内容的准确性。

例如:

用户需要采集与疫情相关的资料,并在主页面输入关键词“流行病”。优采云采集 会将搜索结果合并到一个列表中。

(二) 保存搜索材料

优采云采集具有批量保存搜索素材的功能。

点击【当前页全选】功能,勾选需要的文章,文章会添加到操作面板,方便用户批量保存。

(三) 精确过滤

1、搜索过滤

优采云采集支持按标题、内容、时间、平台、是否原创等参数进行过滤,使搜索内容更加准确。

2、广告过滤

完整的采集神器(优采云采集器使用方法教程的小伙伴使用技巧教程 )

采集交流 • 优采云 发表了文章 • 0 个评论 • 167 次浏览 • 2022-01-21 04:03

)

对于许多行业来说,采集数据是一项重要的工作,它可以用准确的数据指导你的工作。这里给大家带来的优采云采集器是一款采集网页数据的智能软件。很多朋友不知道如何使用优采云采集器。让小编给大家介绍一下优采云采集器的使用教程,感兴趣的朋友一起来看看吧。

优采云采集器软件介绍

优采云采集器是采集网页数据的智能软件。完全基于自主研发的分布式云计算平台。可以轻松从不同的网站抓取网页中大量规范化的数据内容,帮助任何需要从网页获取信息的客户实现数据自动化采集、编辑、规范化、摆脱减少了对人工搜索和数据采集的依赖,从而降低了获取信息的成本,提高了效率。

优采云采集器如何使用优采云采集器如何使用教程

新建一个采集任务,如果要采集某个网站的某类数据,其实就是配置一个任务,任务执行的时候会根据采集对应的数据设置。

设置采集任务的基本信息。基础信息主要是任务组,用于管理多个任务,使用方便。另外就是任务的名字,然后是备注信息,方便记录一些任务的描述。这些信息在有很多任务时非常有用。

最关键的一步是设置采集 进程。这一步是最重要的一步。根据需要的采集顺序,将采集的事情分成几个步骤,然后每一步对应一个采集动作,组合成一个采集步骤,如果如图所示,是采集一个页面的过程,首先打开页面,然后提取页面上的数据。

配置执行计划。有的数据需要一天采集一次,有的一天要采集多次,所以不同的任务需要设置不同的计划。这个任务不需要定期执行,所以选择Manual,然后保存执行计划

至此基本配置完成,接下来就是测试流程是否正确,如果正确就可以开始任务了,采集数据,如果不正确,去返回并修改每一步的配置。放置,继续测试,最终测试完成后即可采集。

查看全部

完整的采集神器(优采云采集器使用方法教程的小伙伴使用技巧教程

)

对于许多行业来说,采集数据是一项重要的工作,它可以用准确的数据指导你的工作。这里给大家带来的优采云采集器是一款采集网页数据的智能软件。很多朋友不知道如何使用优采云采集器。让小编给大家介绍一下优采云采集器的使用教程,感兴趣的朋友一起来看看吧。

优采云采集器软件介绍

优采云采集器是采集网页数据的智能软件。完全基于自主研发的分布式云计算平台。可以轻松从不同的网站抓取网页中大量规范化的数据内容,帮助任何需要从网页获取信息的客户实现数据自动化采集、编辑、规范化、摆脱减少了对人工搜索和数据采集的依赖,从而降低了获取信息的成本,提高了效率。

优采云采集器如何使用优采云采集器如何使用教程

新建一个采集任务,如果要采集某个网站的某类数据,其实就是配置一个任务,任务执行的时候会根据采集对应的数据设置。

设置采集任务的基本信息。基础信息主要是任务组,用于管理多个任务,使用方便。另外就是任务的名字,然后是备注信息,方便记录一些任务的描述。这些信息在有很多任务时非常有用。

最关键的一步是设置采集 进程。这一步是最重要的一步。根据需要的采集顺序,将采集的事情分成几个步骤,然后每一步对应一个采集动作,组合成一个采集步骤,如果如图所示,是采集一个页面的过程,首先打开页面,然后提取页面上的数据。

配置执行计划。有的数据需要一天采集一次,有的一天要采集多次,所以不同的任务需要设置不同的计划。这个任务不需要定期执行,所以选择Manual,然后保存执行计划

至此基本配置完成,接下来就是测试流程是否正确,如果正确就可以开始任务了,采集数据,如果不正确,去返回并修改每一步的配置。放置,继续测试,最终测试完成后即可采集。

完整的采集神器(想了解php采集神器cURL使用方法详解的相关内容吗)

采集交流 • 优采云 发表了文章 • 0 个评论 • 123 次浏览 • 2022-03-19 13:18

想知道php采集神器cURL使用方法详解的相关内容吗?在本文中,Zjmainstay将为大家讲解php采集神器cURL使用方法详解的相关知识和一些代码示例。欢迎阅读和指正。先说重点:php、采集、cURL,一起来学习吧。

做过data采集的朋友,cURL一定不会陌生。虽然PHP中有一个file_get_contents函数可以获取远程链接的数据,但是它的可控性太差了。对于各种复杂的情况采集,file_get_contents 显得有些力不从心。因此,本文将向您介绍采集神器cURL的使用。

我先给大家补充一下file_get_contents函数是如何获取远程链接数据的。

这段代码会直接使用curl来显示文件的内容,但是问题来了,因为curl是php的扩展,有些主机为了安全会金庸curl,而宁外php在本地调试的时候也会关闭curl,所以一个会发生错误。所以这段代码不可取,所以云洛给他重写了

修改后的版本是对curl扩展做判断,看服务器是否开启了curl扩展。如果打开则直接显示该文件,如果未打开则显示提示文字。

虽然问题已经解决,但还有另一个问题。我只是显示一段文字,并没有用任何东西来做大事,那我为什么要写这么多代码呢??

经过一番废话测试,发现file_get_contents获取远程文件内容并不比curl慢,而且在某些文件较少的情况下可能比curl扩展快很多,于是我又重写了代码

工具

火狐+萤火虫

“要想把工作做好,就必须先利好自己的工具。” 在分析案例之前,我们先学习一下如何使用神器 Firebug 来获取我们需要的信息。

使用F12打开Firebug,我们可以得到如图所示的界面(一):

1、箭头图标是“元素选择”工具。单击一次将突出显示该图标。同时,鼠标在页面中的移动会同时选中HTML菜单中的相应内容。当元素被设置时,图标高亮被取消。如图(二):

Firebug 视图元素

2、控制台

JS中console.log系列函数的打印输出到这里。

3、HTML

HTML内容,注意这里看到的不一定是采集要解析的内容,采集时对内容的分析总是基于查看源码(Ctrl+U ),这里只是为了快速定位元素结构,然后在源码中选择一个专门的引用来定位对应的位置。

例如,如果您在 HTML 中看到一个标签

演示

, 但是你看源码时看到的可能是

演示

,如果按照前者对采集的内容进行正则匹配,则不会得到结果。

4、CSS

这是CSS文件内容

5、脚本

这是Javascript文件内容

6、DOM

dom节点内容

7、网络

每个请求链接的数据,这里是我们采集要重点分析的地方,它可以展示每个请求的参数、请求头、cookie数据等。在页面提交会刷新的情况下,需要使用hold,这样刷新后页面请求内容就保留在控制台中,如图(三):

此外,Firefox还有一个Tamper data扩展,也可以获取请求数据,必要时可以安装使用。

8、Cookie

Cookie 数据

在图中(一),我们也看到下面有很多可选的小菜单项,其中keep是我们要注意的。当它被选中时,即使提交了表单并且页面是刷新后,下方内容区的数据依然会被保留,这对于分析提交的数据尤为关键。

总结

我们在分析采集的请求时,主要关心的是“网络”菜单中的请求数据。如有必要,使用“保持”查看刷新页面的请求数据。在发出请求之前,您可以使用“清除”清除以下内容。

案例分析

一、简单采集

这里所说的简单采集是指单个页面GET请求的采集,简单到即使通过file_get_contents函数也可以轻松获取页面返回结果。

代码片段 file_get_contents

<p> 查看全部

完整的采集神器(想了解php采集神器cURL使用方法详解的相关内容吗)

想知道php采集神器cURL使用方法详解的相关内容吗?在本文中,Zjmainstay将为大家讲解php采集神器cURL使用方法详解的相关知识和一些代码示例。欢迎阅读和指正。先说重点:php、采集、cURL,一起来学习吧。

做过data采集的朋友,cURL一定不会陌生。虽然PHP中有一个file_get_contents函数可以获取远程链接的数据,但是它的可控性太差了。对于各种复杂的情况采集,file_get_contents 显得有些力不从心。因此,本文将向您介绍采集神器cURL的使用。

我先给大家补充一下file_get_contents函数是如何获取远程链接数据的。

这段代码会直接使用curl来显示文件的内容,但是问题来了,因为curl是php的扩展,有些主机为了安全会金庸curl,而宁外php在本地调试的时候也会关闭curl,所以一个会发生错误。所以这段代码不可取,所以云洛给他重写了

修改后的版本是对curl扩展做判断,看服务器是否开启了curl扩展。如果打开则直接显示该文件,如果未打开则显示提示文字。

虽然问题已经解决,但还有另一个问题。我只是显示一段文字,并没有用任何东西来做大事,那我为什么要写这么多代码呢??

经过一番废话测试,发现file_get_contents获取远程文件内容并不比curl慢,而且在某些文件较少的情况下可能比curl扩展快很多,于是我又重写了代码

工具

火狐+萤火虫

“要想把工作做好,就必须先利好自己的工具。” 在分析案例之前,我们先学习一下如何使用神器 Firebug 来获取我们需要的信息。

使用F12打开Firebug,我们可以得到如图所示的界面(一):

1、箭头图标是“元素选择”工具。单击一次将突出显示该图标。同时,鼠标在页面中的移动会同时选中HTML菜单中的相应内容。当元素被设置时,图标高亮被取消。如图(二):

Firebug 视图元素

2、控制台

JS中console.log系列函数的打印输出到这里。

3、HTML

HTML内容,注意这里看到的不一定是采集要解析的内容,采集时对内容的分析总是基于查看源码(Ctrl+U ),这里只是为了快速定位元素结构,然后在源码中选择一个专门的引用来定位对应的位置。

例如,如果您在 HTML 中看到一个标签

演示

, 但是你看源码时看到的可能是

演示

,如果按照前者对采集的内容进行正则匹配,则不会得到结果。

4、CSS

这是CSS文件内容

5、脚本

这是Javascript文件内容

6、DOM

dom节点内容

7、网络

每个请求链接的数据,这里是我们采集要重点分析的地方,它可以展示每个请求的参数、请求头、cookie数据等。在页面提交会刷新的情况下,需要使用hold,这样刷新后页面请求内容就保留在控制台中,如图(三):

此外,Firefox还有一个Tamper data扩展,也可以获取请求数据,必要时可以安装使用。

8、Cookie

Cookie 数据

在图中(一),我们也看到下面有很多可选的小菜单项,其中keep是我们要注意的。当它被选中时,即使提交了表单并且页面是刷新后,下方内容区的数据依然会被保留,这对于分析提交的数据尤为关键。

总结

我们在分析采集的请求时,主要关心的是“网络”菜单中的请求数据。如有必要,使用“保持”查看刷新页面的请求数据。在发出请求之前,您可以使用“清除”清除以下内容。

案例分析

一、简单采集

这里所说的简单采集是指单个页面GET请求的采集,简单到即使通过file_get_contents函数也可以轻松获取页面返回结果。

代码片段 file_get_contents

<p>

完整的采集神器(完整的采集数据格式是如何的呢?分享一下)

采集交流 • 优采云 发表了文章 • 0 个评论 • 112 次浏览 • 2022-03-17 15:01

完整的采集神器是可以以实时数据作为参考采集高质量数据的,so,你的采集数据格式是如何的呢?分享一下,仅供参考,能够采集高质量数据的软件,

请使用采访工具,而非模版,比如知乎大v采访的模版可能需要你提供一份高质量的问卷调查问卷,

更新,那几个图,是可以爬,但不想爬。什么样的图才是爬虫爬不到的。

别人随便扯几句,

模版的话代码上好办,

图1这样的:题目是“人工智能是否等同于‘热工程’?”,底下是各种附带图片的文字。有目的的有针对性地采集“热工程”这几个字(包括附带图片文字)应该可以看到很多,不过附带图片文字只是相对比较难找,需要一定的专业经验。采集问题是通过阿里云spark生产环境采集。不过,还是发现了好多问题不是很清楚怎么做爬虫,太多数据抓不到不能归总:有的抓了很多问题没有用上一般模版,有的数据太多用了很多没有用到模版,有的数据多做了一个小按钮数据抓不到;有的采集完不能直接在阿里云做spark应用程序运行,有的不能运行算法而在本地跑,有的没有做归类,有的不能自定义插入一些字段等等。回过头来发现阿里云不提供爬虫服务,也有爬虫版本,抓取速度也不快。想再采集几十个数据点真的很难。 查看全部

完整的采集神器(完整的采集数据格式是如何的呢?分享一下)

完整的采集神器是可以以实时数据作为参考采集高质量数据的,so,你的采集数据格式是如何的呢?分享一下,仅供参考,能够采集高质量数据的软件,

请使用采访工具,而非模版,比如知乎大v采访的模版可能需要你提供一份高质量的问卷调查问卷,

更新,那几个图,是可以爬,但不想爬。什么样的图才是爬虫爬不到的。

别人随便扯几句,

模版的话代码上好办,

图1这样的:题目是“人工智能是否等同于‘热工程’?”,底下是各种附带图片的文字。有目的的有针对性地采集“热工程”这几个字(包括附带图片文字)应该可以看到很多,不过附带图片文字只是相对比较难找,需要一定的专业经验。采集问题是通过阿里云spark生产环境采集。不过,还是发现了好多问题不是很清楚怎么做爬虫,太多数据抓不到不能归总:有的抓了很多问题没有用上一般模版,有的数据太多用了很多没有用到模版,有的数据多做了一个小按钮数据抓不到;有的采集完不能直接在阿里云做spark应用程序运行,有的不能运行算法而在本地跑,有的没有做归类,有的不能自定义插入一些字段等等。回过头来发现阿里云不提供爬虫服务,也有爬虫版本,抓取速度也不快。想再采集几十个数据点真的很难。

完整的采集神器(PHP中有file_get_contents函数可以获取远程链接数据)

采集交流 • 优采云 发表了文章 • 0 个评论 • 76 次浏览 • 2022-03-02 02:14

做过data采集的朋友,cURL一定不会陌生。虽然PHP中有一个file_get_contents函数可以获取远程链接的数据,但是它的可控性太差了。对于各种复杂的情况采集,file_get_contents 显得有些力不从心。因此,本文将向您介绍采集神器cURL的使用。

我先给大家补充一下file_get_contents函数是如何获取远程链接数据的。

这段代码会直接使用curl来显示文件的内容,但是问题来了,因为curl是php的扩展,有些主机为了安全会金庸curl,而宁外php在本地调试的时候也会关闭curl,所以一个会发生错误。所以这段代码不可取,所以云洛给他重写了

修改后的版本是对curl扩展做判断,看服务器是否开启了curl扩展。如果打开则直接显示该文件,如果未打开则显示提示文字。虽然问题已经解决,但还有另一个问题。我只是显示一段文字,并没有用任何东西来做大事,那我为什么要写这么多代码呢?? 经过一番废话测试,发现file_get_contents获取远程文件内容并不比curl慢,而且在某些文件较少的情况下可能比curl扩展快很多,于是我又重写了代码

工具 Firefox (FireFox) + Firebug “如果你想做好,你必须先磨砺你的工具。” 在分析案例之前,我们先学习一下如何使用神器 Firebug 来获取我们需要的信息。使用F12打开Firebug,我们可以得到如图所示的界面(一):

1、箭头图标是“元素选择”工具。单击一次将突出显示该图标。同时,鼠标在页面中的移动会同时选中HTML菜单中的相应内容。当元素被设置时,图标高亮被取消。如图(二):Firebug 视图元素

2、控制台JS中console.log系列函数的打印输出到这里。3、HTMLHTML内容,注意这里看到的不一定是采集要解析的内容,采集时对内容的分析总是基于查看源码(Ctrl +U),这里只是可以快速定位元素的结构,然后在源码中选择一个特殊的引用来定位对应的位置。例如,如果您在 HTML 中看到一个标签

演示

, 但是你看源码时看到的可能是

演示

,如果按照前者对采集的内容进行正则匹配,则不会得到结果。4、CSS这里是CSS文件内容5、Script这里是Javascript文件内容6、DOMDom节点内容7、网络中各个请求链接的数据,这里是我们的采集 重点分析哪里,可以显示每个请求的参数、请求头、cookie数据等。在页面提交会刷新的情况下,需要使用hold,这样刷新后页面请求内容会保留在控制台中,如图(三):

此外,Firefox还有一个Tamper data扩展,也可以获取请求数据,必要时可以安装使用。8、CookiesCookie 数据

在图中(一),我们也看到下面有很多可选的小菜单项,其中keep是我们要注意的。当它被选中时,即使提交了表单并且页面是刷新后,下方内容区的数据依然会被保留,这对于分析提交的数据尤为关键。

总结 我们在分析采集的请求时,主要关心的是“网络”菜单中的请求数据。如有必要,使用“保持”查看刷新页面的请求数据。在发出请求之前,您可以使用“清除”清除以下内容。

案例分析一、Simple采集Simple采集这里指的是单页GET请求采集,简单到即使通过file_get_contents函数也能轻松获取页面返回结果。

代码片段 file_get_contents

<p> 查看全部

完整的采集神器(PHP中有file_get_contents函数可以获取远程链接数据)

做过data采集的朋友,cURL一定不会陌生。虽然PHP中有一个file_get_contents函数可以获取远程链接的数据,但是它的可控性太差了。对于各种复杂的情况采集,file_get_contents 显得有些力不从心。因此,本文将向您介绍采集神器cURL的使用。

我先给大家补充一下file_get_contents函数是如何获取远程链接数据的。

这段代码会直接使用curl来显示文件的内容,但是问题来了,因为curl是php的扩展,有些主机为了安全会金庸curl,而宁外php在本地调试的时候也会关闭curl,所以一个会发生错误。所以这段代码不可取,所以云洛给他重写了

修改后的版本是对curl扩展做判断,看服务器是否开启了curl扩展。如果打开则直接显示该文件,如果未打开则显示提示文字。虽然问题已经解决,但还有另一个问题。我只是显示一段文字,并没有用任何东西来做大事,那我为什么要写这么多代码呢?? 经过一番废话测试,发现file_get_contents获取远程文件内容并不比curl慢,而且在某些文件较少的情况下可能比curl扩展快很多,于是我又重写了代码

工具 Firefox (FireFox) + Firebug “如果你想做好,你必须先磨砺你的工具。” 在分析案例之前,我们先学习一下如何使用神器 Firebug 来获取我们需要的信息。使用F12打开Firebug,我们可以得到如图所示的界面(一):

1、箭头图标是“元素选择”工具。单击一次将突出显示该图标。同时,鼠标在页面中的移动会同时选中HTML菜单中的相应内容。当元素被设置时,图标高亮被取消。如图(二):Firebug 视图元素

2、控制台JS中console.log系列函数的打印输出到这里。3、HTMLHTML内容,注意这里看到的不一定是采集要解析的内容,采集时对内容的分析总是基于查看源码(Ctrl +U),这里只是可以快速定位元素的结构,然后在源码中选择一个特殊的引用来定位对应的位置。例如,如果您在 HTML 中看到一个标签

演示

, 但是你看源码时看到的可能是

演示

,如果按照前者对采集的内容进行正则匹配,则不会得到结果。4、CSS这里是CSS文件内容5、Script这里是Javascript文件内容6、DOMDom节点内容7、网络中各个请求链接的数据,这里是我们的采集 重点分析哪里,可以显示每个请求的参数、请求头、cookie数据等。在页面提交会刷新的情况下,需要使用hold,这样刷新后页面请求内容会保留在控制台中,如图(三):

此外,Firefox还有一个Tamper data扩展,也可以获取请求数据,必要时可以安装使用。8、CookiesCookie 数据

在图中(一),我们也看到下面有很多可选的小菜单项,其中keep是我们要注意的。当它被选中时,即使提交了表单并且页面是刷新后,下方内容区的数据依然会被保留,这对于分析提交的数据尤为关键。

总结 我们在分析采集的请求时,主要关心的是“网络”菜单中的请求数据。如有必要,使用“保持”查看刷新页面的请求数据。在发出请求之前,您可以使用“清除”清除以下内容。

案例分析一、Simple采集Simple采集这里指的是单页GET请求采集,简单到即使通过file_get_contents函数也能轻松获取页面返回结果。

代码片段 file_get_contents

<p>

完整的采集神器(Python进阶资料和高级开发教程,欢迎进阶中和进想深入Python的小伙伴!)

采集交流 • 优采云 发表了文章 • 0 个评论 • 125 次浏览 • 2022-02-28 11:04

python 采集网站数据,本教程使用scrapy spider

1、安装 Scrapy 框架

命令行执行:

pip install scrapy

如果安装的scrapy依赖包与你之前安装的其他python包冲突,建议使用Virtualenv安装

安装完成后,随便找个文件夹创建爬虫

scrapy startproject 你的蜘蛛名称

文件夹目录

/imgrdrct/https://img-blog.csdnimg.cn/20 ... rmark,type_ZmFuZ3poZW5naGVpdGk,shadow_10,text_aHR0cHM6Ly9ibG9nLmNzZG4ubmV0L3dlaXhpbl80NjczNzc1NQ==,size_16,color_FFFFFF,t_70

爬虫规则写在spiders目录中

items.py - 要抓取的数据

pipelines.py - 执行数据保存

设置 - 配置

middlewares.py—下载器

以下是采集小说网站

的源码

首先在items.py中定义采集的数据

# author 小白

import scrapy

class BookspiderItem(scrapy.Item):

# define the fields for your item here like:

i = scrapy.Field()

book_name = scrapy.Field()

book_img = scrapy.Field()

book_author = scrapy.Field()

book_last_chapter = scrapy.Field()

book_last_time = scrapy.Field()

book_list_name = scrapy.Field()

book_content = scrapy.Field()

pass

编写采集规则

保存数据

import os

class BookspiderPipeline(object):

def process_item(self, item, spider):

curPath = 'E:/小说/'

tempPath = str(item['book_name'])

targetPath = curPath + tempPath

if not os.path.exists(targetPath):

os.makedirs(targetPath)

book_list_name = str(str(item['i'])+item['book_list_name'])

filename_path = targetPath+'/'+book_list_name+'.txt'

print('------------')

print(filename_path)

with open(filename_path,'a',encoding='utf-8') as f:

f.write(item['book_content'])

return item

执行

scrapy crawl BookSpider

采集

完成一个新颖的程序

在这里推荐

scrapy shell 爬取的网页url

然后 response.css('') 测试规则是否正确

推荐我自己建的Python开发学习群:810735403,群都是通过学习Python开发的。如果您正在学习 Python,欢迎您加入。大家都是软件开发党,时不时分享干货。 (仅与Python软件开发相关),包括我自己编译的2020年最新Python进阶资料和进阶开发教程的副本。欢迎有志于深入 Python 的进阶伙伴! 查看全部

完整的采集神器(Python进阶资料和高级开发教程,欢迎进阶中和进想深入Python的小伙伴!)

python 采集网站数据,本教程使用scrapy spider

1、安装 Scrapy 框架

命令行执行:

pip install scrapy

如果安装的scrapy依赖包与你之前安装的其他python包冲突,建议使用Virtualenv安装

安装完成后,随便找个文件夹创建爬虫

scrapy startproject 你的蜘蛛名称

文件夹目录

/imgrdrct/https://img-blog.csdnimg.cn/20 ... rmark,type_ZmFuZ3poZW5naGVpdGk,shadow_10,text_aHR0cHM6Ly9ibG9nLmNzZG4ubmV0L3dlaXhpbl80NjczNzc1NQ==,size_16,color_FFFFFF,t_70

爬虫规则写在spiders目录中

items.py - 要抓取的数据

pipelines.py - 执行数据保存

设置 - 配置

middlewares.py—下载器

以下是采集小说网站

的源码

首先在items.py中定义采集的数据

# author 小白

import scrapy

class BookspiderItem(scrapy.Item):

# define the fields for your item here like:

i = scrapy.Field()

book_name = scrapy.Field()

book_img = scrapy.Field()

book_author = scrapy.Field()

book_last_chapter = scrapy.Field()

book_last_time = scrapy.Field()

book_list_name = scrapy.Field()

book_content = scrapy.Field()

pass

编写采集规则

保存数据

import os

class BookspiderPipeline(object):

def process_item(self, item, spider):

curPath = 'E:/小说/'

tempPath = str(item['book_name'])

targetPath = curPath + tempPath

if not os.path.exists(targetPath):

os.makedirs(targetPath)

book_list_name = str(str(item['i'])+item['book_list_name'])

filename_path = targetPath+'/'+book_list_name+'.txt'

print('------------')

print(filename_path)

with open(filename_path,'a',encoding='utf-8') as f:

f.write(item['book_content'])

return item

执行

scrapy crawl BookSpider

采集

完成一个新颖的程序

在这里推荐

scrapy shell 爬取的网页url

然后 response.css('') 测试规则是否正确

推荐我自己建的Python开发学习群:810735403,群都是通过学习Python开发的。如果您正在学习 Python,欢迎您加入。大家都是软件开发党,时不时分享干货。 (仅与Python软件开发相关),包括我自己编译的2020年最新Python进阶资料和进阶开发教程的副本。欢迎有志于深入 Python 的进阶伙伴!

完整的采集神器(大数据可视化通用模板项目使用说明总结(一)|废话不说 )

采集交流 • 优采云 发表了文章 • 0 个评论 • 136 次浏览 • 2022-02-23 21:18

)

废话不多说,先上传动画吧,有点大,请耐心等待

大数据可视化展板通用模板项目介绍

项目基本结构

项目基本结构安装创建虚拟环境,安装Flask运行项目及使用总结

虽然这个项目的效果很惊艳,但是实现起来还是比较简单的。只要掌握一些flask、html、echarts的基础知识,就可以定制属于自己的数据可视化大屏,提升自己在老板心中的价值,是不是很棒呢?香

扫码免费获取10000个代理IP,高并发不限,稳定速度快,去毛线!

精选文章系列视频|Python网络爬虫与文本数据分析B站视频 | Python自动化办公

SciencePlots | 科研样式绘图库使用streamlit上线中文文本分析网站

bsite库 | 采集B站视频信息、评论数据

texthero包 | 支持dataframe的文本分析包爬虫实战 | 采集&可视化知乎问题的回答reticulate包 | 在Rmarkdown中调用Python代码plydata库 | 数据操作管道操作符>>plotnine: Python版的ggplot2作图库读完本文你就了解什么是文本分析

文本分析在经管领域中的应用概述 综述:文本分析在市场营销研究中的应用

plotnine: Python版的ggplot2作图库Wow~70G上市公司定期报告数据集

漂亮~pandas可以无缝衔接Bokeh YelpDaset: 酒店管理类数据集10+G 查看全部

完整的采集神器(大数据可视化通用模板项目使用说明总结(一)|废话不说

)

废话不多说,先上传动画吧,有点大,请耐心等待

大数据可视化展板通用模板项目介绍

项目基本结构

项目基本结构安装创建虚拟环境,安装Flask运行项目及使用总结

虽然这个项目的效果很惊艳,但是实现起来还是比较简单的。只要掌握一些flask、html、echarts的基础知识,就可以定制属于自己的数据可视化大屏,提升自己在老板心中的价值,是不是很棒呢?香

扫码免费获取10000个代理IP,高并发不限,稳定速度快,去毛线!

精选文章系列视频|Python网络爬虫与文本数据分析B站视频 | Python自动化办公

SciencePlots | 科研样式绘图库使用streamlit上线中文文本分析网站

bsite库 | 采集B站视频信息、评论数据

texthero包 | 支持dataframe的文本分析包爬虫实战 | 采集&可视化知乎问题的回答reticulate包 | 在Rmarkdown中调用Python代码plydata库 | 数据操作管道操作符>>plotnine: Python版的ggplot2作图库读完本文你就了解什么是文本分析

文本分析在经管领域中的应用概述 综述:文本分析在市场营销研究中的应用

plotnine: Python版的ggplot2作图库Wow~70G上市公司定期报告数据集

漂亮~pandas可以无缝衔接Bokeh YelpDaset: 酒店管理类数据集10+G

完整的采集神器(先给file_get_contents函数可以获取远程链接数据的方法)

采集交流 • 优采云 发表了文章 • 0 个评论 • 165 次浏览 • 2022-02-18 05:23

做过data采集的朋友,curl一定不会陌生。虽然php中有file_get_contents函数可以获取远程链接的数据,但是可控性太差。对于各种复杂的情况采集,file_get_contents 显得有些力不从心。因此,本文将向您介绍采集神器curl的使用。

我先给大家补充一下file_get_contents函数是如何获取远程链接数据的。

这段代码会直接使用curl来显示文件内容,但是问题来了,因为curl是php的扩展,有些主机为了安全会金庸curl,而宁外php在本地调试的时候也会关闭curl,所以会报错发生。所以这段代码不可取,所以云洛给他重写了

修改后的版本是对curl扩展做判断,看服务器是否开启了curl扩展。如果打开则直接显示该文件,如果未打开则显示提示文字。

虽然问题已经解决,但还有另一个问题。我只是显示一段文字,并没有用任何东西来做大事,那我为什么要写这么多代码呢??

经过一番废话测试,发现file_get_contents获取远程文件内容并不比curl慢,而且在某些文件较少的情况下可能比curl扩展快很多,于是我又重写了代码

工具

火狐+萤火虫

“要想把工作做好,就必须先利好自己的工具。” 在分析案例之前,让我们学习一下如何使用神器firebug来获取我们需要的信息。

使用f12打开firebug,我们可以得到如图所示的界面(一):

1、箭头图标是“元素选择”工具。单击一次将突出显示该图标。同时,鼠标在页面中的移动会同时选中html菜单中的相应内容。当元素被设置时,图标高亮被取消。如图(二):

萤火虫视图元素

2、控制台

js中console.log系列函数的打印输出到这里。

3、html

html内容,注意这里看到的不一定是采集要解析的内容。采集 的时候对内容的分析总是基于查看源码(ctrl+u),也就是快速定位元素。结构,然后选择一个特殊的引用来定位源代码中的对应位置。

例如,您在 html 中看到一个标签,即

演示

, 但是你看源码时看到的可能是