可靠的采集神器

qunee用心服务平台,每天与您相约不见不散!

采集交流 • 优采云 发表了文章 • 0 个评论 • 393 次浏览 • 2021-02-13 09:01

可靠的采集神器qunee用心服务平台每天与您相约不见不散!“最强ai爬虫。”“机器视觉下载器。”目前,市面上大部分采集工具对于爬虫来说最多是“可使用,稳定”,但qunee家的采集工具能从海量数据库中获取你想要的数据,其数据爬取速度稳定而迅速,主要抓取国内自媒体平台的内容。

首先啊,我想说的是,在微信搜索“带我飞ai公众号”,你会看到很多的微信公众号的数据采集接口,包括很多地方我已经在带我飞网站上都接了微信公众号的数据,所以呢,不用担心这个问题。感兴趣的话,可以通过微信搜索进入我们的主页观看。这是我们网站上的接口截图,你感兴趣的话可以来看看。

不行,你要出天价给人家,说给你数据,都好几万.根本抢不过来的.比如你给我一篇2016-2018年的国内外互联网流量,我找到2018年的,爬下来都是4-5-6w..那都是几万几十万的.真心这么暴利吗,找几百个专业的牛逼的爬虫集团,你们给我的数据,都还不如人家。你们还自己花钱买这个,不是蠢,就是坏.数据分析方面的,再给你分析分析出点花样.如果你们卖数据,拿差价,好歹往下带那么几万上千万的项目,挣点钱怎么了...但是如果你们继续跟风搞这个,你们只会把整个社会的数据整个不稀缺了。都归我承包了..。 查看全部

qunee用心服务平台,每天与您相约不见不散!

可靠的采集神器qunee用心服务平台每天与您相约不见不散!“最强ai爬虫。”“机器视觉下载器。”目前,市面上大部分采集工具对于爬虫来说最多是“可使用,稳定”,但qunee家的采集工具能从海量数据库中获取你想要的数据,其数据爬取速度稳定而迅速,主要抓取国内自媒体平台的内容。

首先啊,我想说的是,在微信搜索“带我飞ai公众号”,你会看到很多的微信公众号的数据采集接口,包括很多地方我已经在带我飞网站上都接了微信公众号的数据,所以呢,不用担心这个问题。感兴趣的话,可以通过微信搜索进入我们的主页观看。这是我们网站上的接口截图,你感兴趣的话可以来看看。

不行,你要出天价给人家,说给你数据,都好几万.根本抢不过来的.比如你给我一篇2016-2018年的国内外互联网流量,我找到2018年的,爬下来都是4-5-6w..那都是几万几十万的.真心这么暴利吗,找几百个专业的牛逼的爬虫集团,你们给我的数据,都还不如人家。你们还自己花钱买这个,不是蠢,就是坏.数据分析方面的,再给你分析分析出点花样.如果你们卖数据,拿差价,好歹往下带那么几万上千万的项目,挣点钱怎么了...但是如果你们继续跟风搞这个,你们只会把整个社会的数据整个不稀缺了。都归我承包了..。

官方数据:推荐5个目前最好的网页数据采集神器

采集交流 • 优采云 发表了文章 • 0 个评论 • 726 次浏览 • 2020-12-16 10:16

在Internet +数据+人工智能时代,对Web数据的需求越来越多采集,并且有很多情况。 Web数据采集在企业中的实际应用也在显着增加。在实际工作中,可能需要获取旅行的飞行时间或Airbnb清单网站,或者可能需要采集数据(例如来自不同电子商务的价格表网站)进行价格比较。在许多情况下,它也超出了个人需求,例如采集用于机器学习的培训和测试数据集。这是网页数据采集发挥作用的地方。

在这里,我们将探索最好的网络数据采集工具。

1.木偶

Puppeteer是Google发布的“最终”重大举措。它不仅是网页数据采集工具,而且实际上是Node库。它提供了类似于Selenium Webdriver的高级API的高级API。默认的它通过DevTools协议控制无界面的Chrome,也可以通过配置用于界面的Chrome。

使用木偶,我们可以做以下事情:

#用于生成网页的屏幕截图或PDF文件。

#用于创建新的自动化测试环境。

#用于捕获网页的时间轴轨迹以诊断性能问题。

#抓取SPA(单页应用程序)并生成内容,然后再渲染网页(服务器端渲染(SSR))。

API与自然语言一样简洁明了,无需回调,只需几行代码就可以完成我们需要的一切。

2.Cheerio

Cheerio是一个标记解析库,提供用于解析结果数据(例如服务器接口返回的数据)结构的API。关于Cheerio最好的事情是它不会像Web浏览器那样解释结果数据。但是,它既不会产生视觉效果,也不会加载外部资源或请求CSS。如果实际项目中需要这些功能,则需要考虑PhantomJS之类的项目。

值得注意的是,在Cheerio中使用Node.js 采集数据要容易得多。

例如采集:

3.请求承诺

Request-Promise是npm库的变体,它通过自动浏览器提供了更快的解决方案。如果内容不是动态呈现的,则可以使用此网页数据采集工具。如果要处理的网站具有身份验证系统,则它可能是更高级的解决方案。如果将其与Puppeteer进行比较,则其用法恰恰相反。

4.噩梦

Nightmare是高级的浏览器自动化库,它以浏览器的形式运行Electron程序。 Electron()是使用JavaScript,HTML和CSS创建本机程序的框架。它与Mac,Windows和Linux兼容。它可以为三个平台构建桌面应用程序。它负责更困难的部分。我们只需要专注于应用程序的核心[Electron刚刚加入OpenJS Foundation]。噩梦是精简版,或者可以说是Puppeteer的简化版。它具有可提供更大灵活性的插件,包括对文件下载的支持。

噩梦的目标是公开一些似乎是同步的方法调用,例如goto,type和click,而不是深度嵌套的回调。它最初旨在在不使用API的情况下自动执行站点之间的任务,但最常用于UI测试和数据采集。

您还可以运行摩卡测试。

5.渗透

Osmosis是HTML / XML解析器和网页数据采集工具。它用Node.js编写,并与CSS3 / xpath选择器和轻量级HTTP包装器打包在一起。如果将其与Cheerio,jQuery和jsdom进行比较,则没有明显的依赖性。

示例代码如下:

[202001] 查看全部

官方数据:推荐5个目前最好的网页数据采集神器

在Internet +数据+人工智能时代,对Web数据的需求越来越多采集,并且有很多情况。 Web数据采集在企业中的实际应用也在显着增加。在实际工作中,可能需要获取旅行的飞行时间或Airbnb清单网站,或者可能需要采集数据(例如来自不同电子商务的价格表网站)进行价格比较。在许多情况下,它也超出了个人需求,例如采集用于机器学习的培训和测试数据集。这是网页数据采集发挥作用的地方。

在这里,我们将探索最好的网络数据采集工具。

1.木偶

Puppeteer是Google发布的“最终”重大举措。它不仅是网页数据采集工具,而且实际上是Node库。它提供了类似于Selenium Webdriver的高级API的高级API。默认的它通过DevTools协议控制无界面的Chrome,也可以通过配置用于界面的Chrome。

使用木偶,我们可以做以下事情:

#用于生成网页的屏幕截图或PDF文件。

#用于创建新的自动化测试环境。

#用于捕获网页的时间轴轨迹以诊断性能问题。

#抓取SPA(单页应用程序)并生成内容,然后再渲染网页(服务器端渲染(SSR))。

API与自然语言一样简洁明了,无需回调,只需几行代码就可以完成我们需要的一切。

2.Cheerio

Cheerio是一个标记解析库,提供用于解析结果数据(例如服务器接口返回的数据)结构的API。关于Cheerio最好的事情是它不会像Web浏览器那样解释结果数据。但是,它既不会产生视觉效果,也不会加载外部资源或请求CSS。如果实际项目中需要这些功能,则需要考虑PhantomJS之类的项目。

值得注意的是,在Cheerio中使用Node.js 采集数据要容易得多。

例如采集:

3.请求承诺

Request-Promise是npm库的变体,它通过自动浏览器提供了更快的解决方案。如果内容不是动态呈现的,则可以使用此网页数据采集工具。如果要处理的网站具有身份验证系统,则它可能是更高级的解决方案。如果将其与Puppeteer进行比较,则其用法恰恰相反。

4.噩梦

Nightmare是高级的浏览器自动化库,它以浏览器的形式运行Electron程序。 Electron()是使用JavaScript,HTML和CSS创建本机程序的框架。它与Mac,Windows和Linux兼容。它可以为三个平台构建桌面应用程序。它负责更困难的部分。我们只需要专注于应用程序的核心[Electron刚刚加入OpenJS Foundation]。噩梦是精简版,或者可以说是Puppeteer的简化版。它具有可提供更大灵活性的插件,包括对文件下载的支持。

噩梦的目标是公开一些似乎是同步的方法调用,例如goto,type和click,而不是深度嵌套的回调。它最初旨在在不使用API的情况下自动执行站点之间的任务,但最常用于UI测试和数据采集。

您还可以运行摩卡测试。

5.渗透

Osmosis是HTML / XML解析器和网页数据采集工具。它用Node.js编写,并与CSS3 / xpath选择器和轻量级HTTP包装器打包在一起。如果将其与Cheerio,jQuery和jsdom进行比较,则没有明显的依赖性。

示例代码如下:

[202001]

行业解决方案:美团商家信息采集神器!Python采集所有商家信息

采集交流 • 优采云 发表了文章 • 0 个评论 • 771 次浏览 • 2020-10-29 11:01

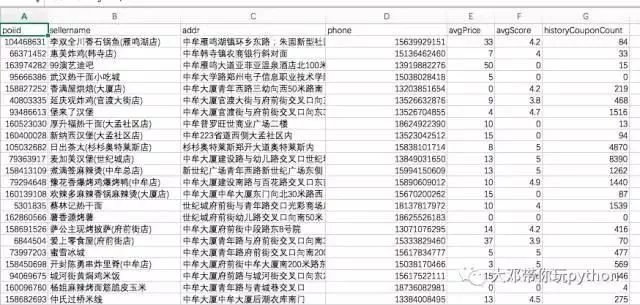

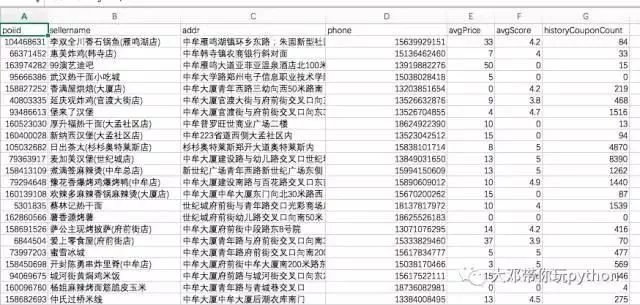

在github上找到一个美团项目,您可以获取指定城市的商业信息,每分钟都有数百种商业信息的数据在您的手,这些信息包括商店名称,地理位置,等级,销售,电话(这就是重点)。

距我更新已经很久了。今天,我写了文章,并附上了这个有价值的项目下载地址。

本文是您自己编写的xpath注释。如果您不想阅读它,可以转到文章底部代码下载地址。

很遗憾该项目是草率编写的。实际上,我不想使用框架,但是花了一天的时间将此项目更改为可以运行的代码。在更改过程中,我再次熟悉了scrapy。决定学习xpath,后来又开始草率地编写一些爬虫。

Python学习交流小组:1004391443,这是python学习者的聚会场所,这里有专家回答问题和共享资源!编辑器还准备了python学习资料。欢迎那些想要学习python编程或改变职业的人,大学生以及那些希望提高工作能力的人加入学习。

除了CSS之外,scrapy的选择器比xpath更好。现在您需要练习使用xpath。

Xpath简介

通常来说,使用id,name,class和其他属性来定位节点可以解决大多数解析需求,但是有时在以下情况下使用Xpath更方便:

没有诸如id,名称,类之类的标签属性,或者文本功能不明显。标签的嵌套级别太复杂。

Xpath是XML Path的简介。基于XML树结构,您可以在整个树中找到目标节点。由于HTML文档本身是标准的XML页面,因此我们可以使用XPath语法来查找页面元素。

Xpath定位方法

一、Xpath路径

符号名称/绝对路径的意思是从根节点中选择//相对路径意味着从任何位置选择一个节点,而不管它们的位置

Xpath路径示例

定位节点

#查找html下的body下的form下的所有input节点/html/body/form/input#查找所有input节点//input

通配符*选择未知节点

#查找form节点下的所有节点//form/*#查找所有节点//*#查找所有input节点(input至少有爷爷辈亲戚节点)//*/input

二、使用索引(这是我自己的理解)

如果在过滤元素时有多个节点,但是我们要确定唯一的节点。您可以使用类似于列表索引的方法进行精确定位。

案例

#定位 第8个td下的 第2个a节点//*/td[7]/a[1]#定位 第8个td下的 第3个span节点//*/td[7]/span[2]#定位 最后一个td下的 最后一个a节点//*/td[last()]/a[last()]

三、使用属性

为了使定位更准确,类似于使用索引,我们需要增加信息量,因此也可以使用属性。 @符号是属性符号

#定位所有包含name属性的input节点//input[@name]#定位含有属性的所有的input节点//input[@*]#定位所有value=2的input节点//input[@value='2']#使用多个属性定位//input[@value='2'][@id='3']或者//input[@value='2' and @id='3']

四、常用功能

除索引和属性外,Xpath还可以使用便捷的功能来提高定位的准确性。以下是一些常用功能:

函数的含义contains(s1,s2)如果s1收录s2,则返回true;否则,返回falsetext()以获取节点中的文本内容starts-with()与实际位置的字符串匹配

应用推广#定位href属性中包含“promote.html”的所有a节点//a[contains(@href,'promote.html')]#元素内的文本为“应用推广”的所有a节点//a[text()='应用推广']#href属性值是以“/ads”开头的所有a节点//a[starts-with(@href,'/ads')]

五、Xpath轴

这部分类似于BeautifulSoup中的同级,父级和子级方法。有时,为了实现定位,有必要进行环形交叉路口,然后七个姨妈和八个姨妈的远亲走来走去,然后他们彼此认识,并且位置就在那里。

轴名称表示祖先选择当前节点的所有祖先(父亲,祖父等)。祖先或自身选择当前节点的所有祖先(父亲,祖父等),而当前节点自己的属性选择全部当前节点的属性子节点选择当前节点节点的所有后代节点选择当前节点的所有后代节点(子节点,孙子节点等),后代或自身选择当前节点的所有后代节点(子节点,孙子节点等),以及当前节点自身的后继节点选择当前节点末尾之后的节点。所有节点的父节点选择当前节点的父节点。兄弟姐妹选择相同级别的所有节点,然后当前节点自身选择当前节点。

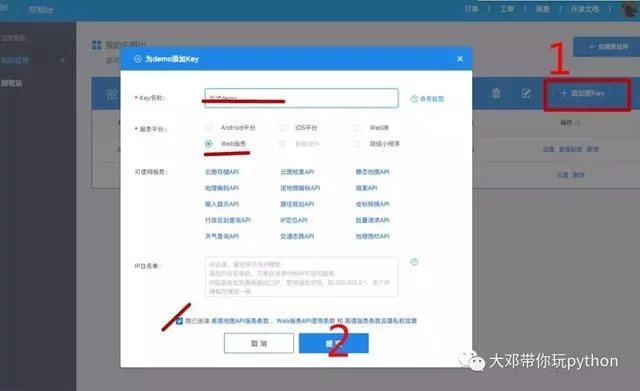

六、美团商家信息

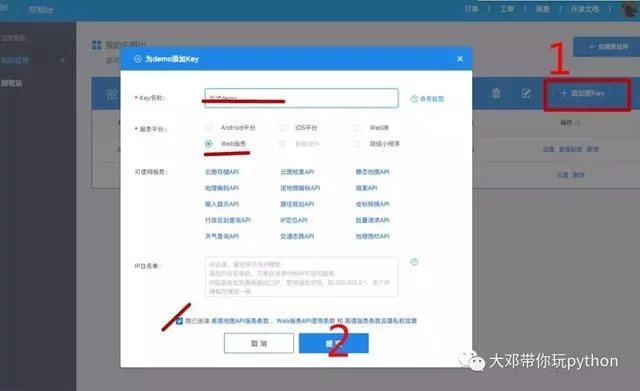

在代码中,我提供了一个高科技的api_key,但是如果您过多使用它,则实际上将无法使用它。我建议你自己申请。

#在高德注册,进入控制台http://lbs.amap.com/

广告中几乎没有人知道,对于50岁的阿姨来说,一勺灵芝孢子粉也会像这样改变

这是几十秒内采集中郑州市的数据。

提示:

修改高德api_key

在项目中找到设置,并将GAODEAPIKEY参数修改为您的应用程序编号的api_key。

更改城市

在项目中找到设置,然后将CITY_NAME参数修改为所需的城市采集

运行主程序采集数据

在项目文件夹中找到main.py并运行它以愉快地获取数据并将其保存到data.csv。 查看全部

美团商务信息采集神器! Python 采集所有业务信息

在github上找到一个美团项目,您可以获取指定城市的商业信息,每分钟都有数百种商业信息的数据在您的手,这些信息包括商店名称,地理位置,等级,销售,电话(这就是重点)。

距我更新已经很久了。今天,我写了文章,并附上了这个有价值的项目下载地址。

本文是您自己编写的xpath注释。如果您不想阅读它,可以转到文章底部代码下载地址。

很遗憾该项目是草率编写的。实际上,我不想使用框架,但是花了一天的时间将此项目更改为可以运行的代码。在更改过程中,我再次熟悉了scrapy。决定学习xpath,后来又开始草率地编写一些爬虫。

Python学习交流小组:1004391443,这是python学习者的聚会场所,这里有专家回答问题和共享资源!编辑器还准备了python学习资料。欢迎那些想要学习python编程或改变职业的人,大学生以及那些希望提高工作能力的人加入学习。

除了CSS之外,scrapy的选择器比xpath更好。现在您需要练习使用xpath。

Xpath简介

通常来说,使用id,name,class和其他属性来定位节点可以解决大多数解析需求,但是有时在以下情况下使用Xpath更方便:

没有诸如id,名称,类之类的标签属性,或者文本功能不明显。标签的嵌套级别太复杂。

Xpath是XML Path的简介。基于XML树结构,您可以在整个树中找到目标节点。由于HTML文档本身是标准的XML页面,因此我们可以使用XPath语法来查找页面元素。

Xpath定位方法

一、Xpath路径

符号名称/绝对路径的意思是从根节点中选择//相对路径意味着从任何位置选择一个节点,而不管它们的位置

Xpath路径示例

定位节点

#查找html下的body下的form下的所有input节点/html/body/form/input#查找所有input节点//input

通配符*选择未知节点

#查找form节点下的所有节点//form/*#查找所有节点//*#查找所有input节点(input至少有爷爷辈亲戚节点)//*/input

二、使用索引(这是我自己的理解)

如果在过滤元素时有多个节点,但是我们要确定唯一的节点。您可以使用类似于列表索引的方法进行精确定位。

案例

#定位 第8个td下的 第2个a节点//*/td[7]/a[1]#定位 第8个td下的 第3个span节点//*/td[7]/span[2]#定位 最后一个td下的 最后一个a节点//*/td[last()]/a[last()]

三、使用属性

为了使定位更准确,类似于使用索引,我们需要增加信息量,因此也可以使用属性。 @符号是属性符号

#定位所有包含name属性的input节点//input[@name]#定位含有属性的所有的input节点//input[@*]#定位所有value=2的input节点//input[@value='2']#使用多个属性定位//input[@value='2'][@id='3']或者//input[@value='2' and @id='3']

四、常用功能

除索引和属性外,Xpath还可以使用便捷的功能来提高定位的准确性。以下是一些常用功能:

函数的含义contains(s1,s2)如果s1收录s2,则返回true;否则,返回falsetext()以获取节点中的文本内容starts-with()与实际位置的字符串匹配

应用推广#定位href属性中包含“promote.html”的所有a节点//a[contains(@href,'promote.html')]#元素内的文本为“应用推广”的所有a节点//a[text()='应用推广']#href属性值是以“/ads”开头的所有a节点//a[starts-with(@href,'/ads')]

五、Xpath轴

这部分类似于BeautifulSoup中的同级,父级和子级方法。有时,为了实现定位,有必要进行环形交叉路口,然后七个姨妈和八个姨妈的远亲走来走去,然后他们彼此认识,并且位置就在那里。

轴名称表示祖先选择当前节点的所有祖先(父亲,祖父等)。祖先或自身选择当前节点的所有祖先(父亲,祖父等),而当前节点自己的属性选择全部当前节点的属性子节点选择当前节点节点的所有后代节点选择当前节点的所有后代节点(子节点,孙子节点等),后代或自身选择当前节点的所有后代节点(子节点,孙子节点等),以及当前节点自身的后继节点选择当前节点末尾之后的节点。所有节点的父节点选择当前节点的父节点。兄弟姐妹选择相同级别的所有节点,然后当前节点自身选择当前节点。

六、美团商家信息

在代码中,我提供了一个高科技的api_key,但是如果您过多使用它,则实际上将无法使用它。我建议你自己申请。

#在高德注册,进入控制台http://lbs.amap.com/

广告中几乎没有人知道,对于50岁的阿姨来说,一勺灵芝孢子粉也会像这样改变

这是几十秒内采集中郑州市的数据。

提示:

修改高德api_key

在项目中找到设置,并将GAODEAPIKEY参数修改为您的应用程序编号的api_key。

更改城市

在项目中找到设置,然后将CITY_NAME参数修改为所需的城市采集

运行主程序采集数据

在项目文件夹中找到main.py并运行它以愉快地获取数据并将其保存到data.csv。

详细数据:用户行为分析之数据采集

采集交流 • 优采云 发表了文章 • 0 个评论 • 289 次浏览 • 2020-10-12 09:00

用户行为简介

用户行为分析的主要指标可以概括如下:哪个用户执行了什么操作,在哪里进行了操作,为什么要进行这些操作,通过什么方法,花费了多长时间以及其他问题,归纳为WHO,何时,何地,什么,为什么以及如何?时间。

基于以上5个W和2H,让我们讨论如何实现它们。

WHO,首先,您需要x以获得登录用户的个人信息。用户名,角色等。

何时获取用户访问页面每个模块的时间,开始时间,结束时间等

什么,在获取用户登录页面后已经执行了哪些操作,单击了哪些页面和模块,等等。

为什么,分析用户点击这些模块的目的

如何,用户如何访问系统,网络,APP,小程序等。

HOW TIME,用户访问每个模块多长时间,浏览特定页面等

以上是我们需要获取的所有数据。只有获得相关数据,我们才能分析用户行为。

用户行为数据采集掩埋点

掩埋点通常分为非掩埋点和代码掩埋点。这两个都有各自的优缺点,这里仅作简要介绍:

全掩埋点是一种前端掩埋方法。 SDK嵌入在产品中,这是最统一的掩埋点。关键行为是通过接口配置方法定义的,以完成埋入点采集,这是前端的埋入点方式之一。

优势:

缺点:

作为前端掩埋点,会有一些自然的缺点

代码掩埋点,这也是我们当前使用的掩埋方法。代码埋入点分为前端代码埋入点和后端代码埋入点。前端埋入点类似于完整埋入点,并且还需要嵌入到SDK中。区别在于对于每种事件行为,您需要调用SDK代码,传入必要的事件名称,属性参数等,然后将其发送到后台数据服务器。后端嵌入式点通过调用SDK接口的后端模块将事件和属性发送到后端服务器。

我们使用代码掩埋点,将其分为前端和后端。嵌入是一个特别重要的过程。它是数据的来源。如果数据源存在问题,则数据本身存在问题,分析结果将失去意义。

因为我负责日志检测,即埋入点之后事件日志的检测警报,并通知相应的埋入点开发人员,操作员和产品方面,所以我遇到了很多凹坑,其中大多数是过程。

事件属性具有元数据管理系统,并且行业中的某些服务也具有此结构。通常,首先定义事件和属性,然后掩埋点。原因是需要检查事件日志数据。有必要检查事件是否存在,属性是否丢失,数据是否正常等等。

遇到的坑

数据错误。这种情况很难发现。需要在操作产品的分析中找到它。这也有点不舒服

基于上述想法,让我们谈谈实现的相关技术问题以及如何进行用户行为分析。

数据采集

根据操作定义的嵌入式点接口形式获取的用户访问日志数据,必须预先在后端和前端定义数据存储格式,即字段内容为保存,并且嵌入点数据需要符合协议。格式统一并封装起来,以便于存储和分析。

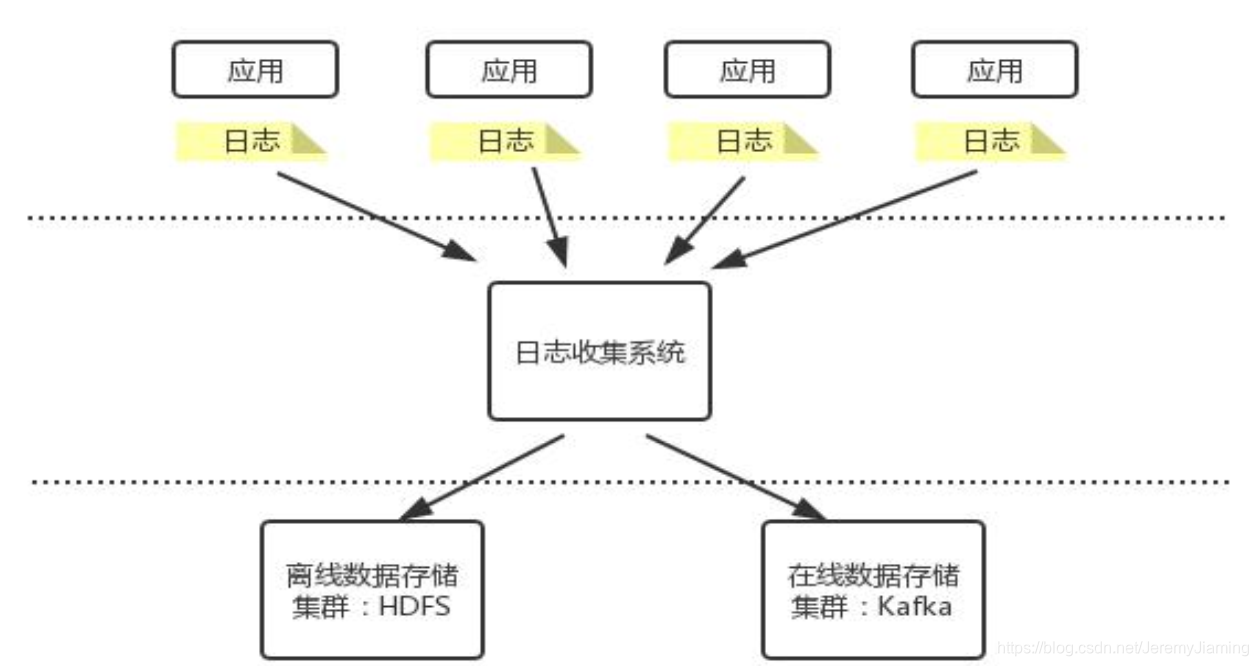

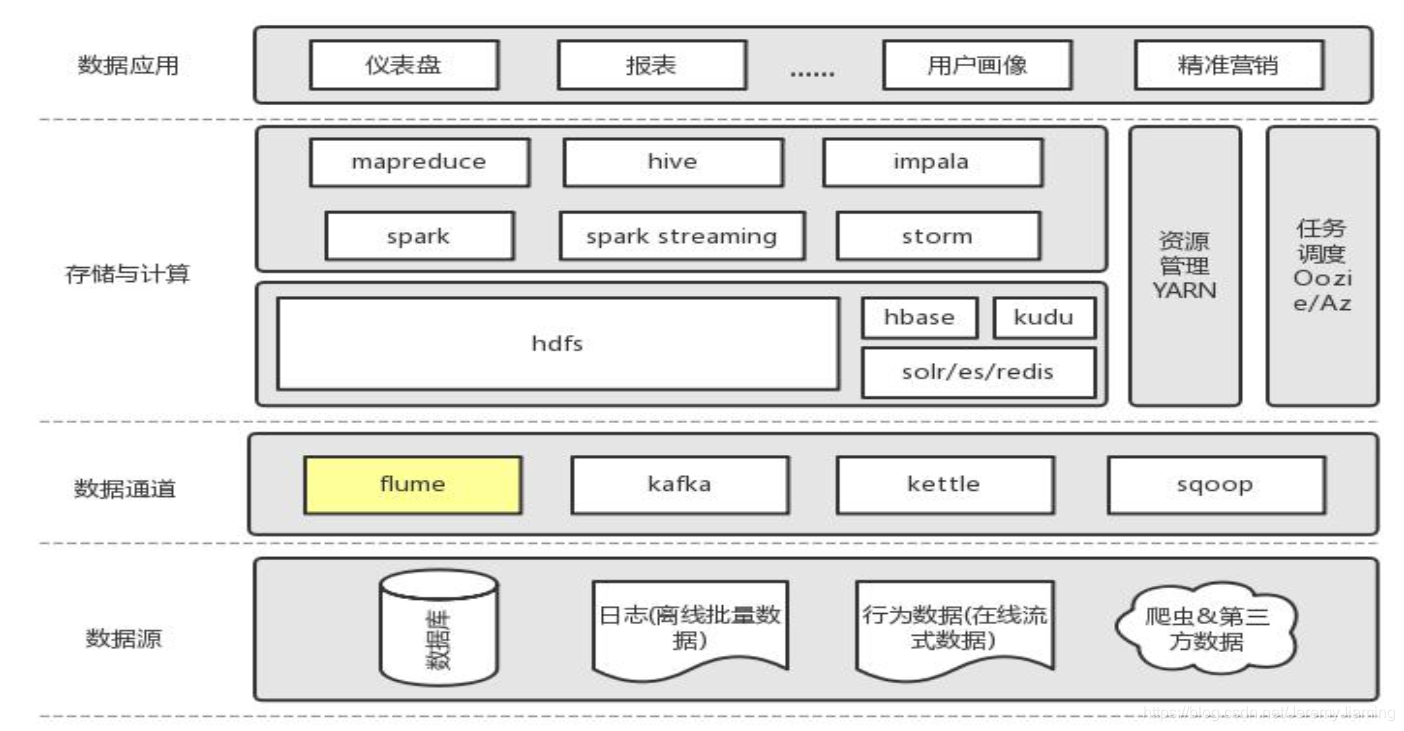

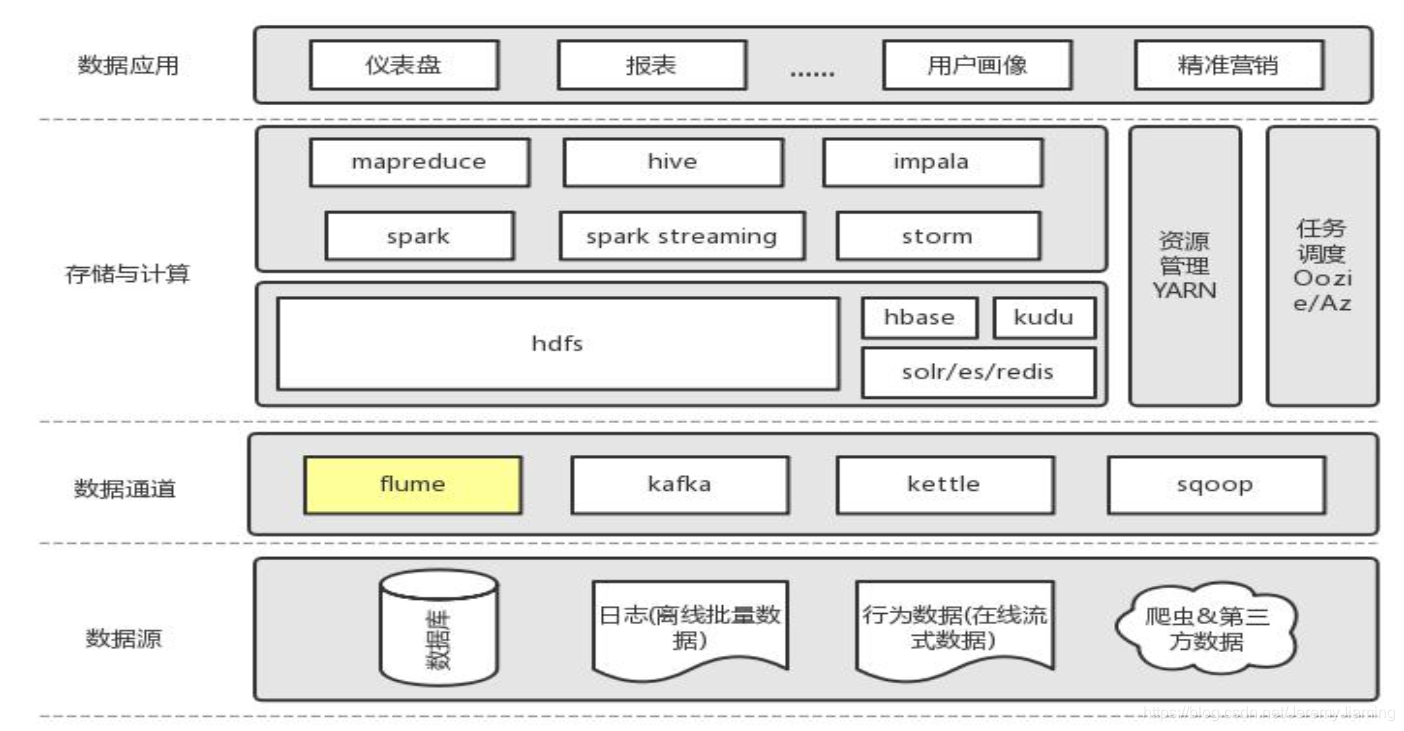

以下数据采集神器Flume已耗尽。

实时掩埋点数据采集通常有两种方法:

直接触发的日志将发送到指定的HTTP端口,并写入kafka,然后Flume将kafka消耗到HDFS用户访问日志到磁盘,在相应的主机上部署flume代理,并将文件发送到采集记录目录到Kafka,然后将Flume部署到云中以将Kafka数据消耗到HDFS中

然后,Flume 采集系统的安装相对简单,只需两个步骤:

flume配置模板:

a1.sources = source1

a1.sinks = k1

a1.channels = c1

a1.sources.source1.type = org.apache.flume.source.kafka.KafkaSource

a1.sources.source1.channels = c1

a1.sources.source1.kafka.bootstrap.servers = kafka-host1:port1,kafka-host2:port2...

a1.sources.source1.kafka.topics = flume-test

a1.sources.source1.kafka.consumer.group.id = flume-test-group

# Describe the sink

a1.sinks.k1.type = hdfs

a1.sinks.k1.hdfs.path = /tmp/flume/test-data

a1.sinks.k1.hdfs.fileType=DataStream

# Use a channel which buffers events in memory

a1.channels.c1.type = memory

a1.channels.c1.capacity = 100

a1.channels.c1.transactionCapacity = 100

# Bind the source and sink to the channel

a1.sources.source1.channels = c1

a1.sinks.k1.channel = c1 查看全部

用户行为分析数据采集

用户行为简介

用户行为分析的主要指标可以概括如下:哪个用户执行了什么操作,在哪里进行了操作,为什么要进行这些操作,通过什么方法,花费了多长时间以及其他问题,归纳为WHO,何时,何地,什么,为什么以及如何?时间。

基于以上5个W和2H,让我们讨论如何实现它们。

WHO,首先,您需要x以获得登录用户的个人信息。用户名,角色等。

何时获取用户访问页面每个模块的时间,开始时间,结束时间等

什么,在获取用户登录页面后已经执行了哪些操作,单击了哪些页面和模块,等等。

为什么,分析用户点击这些模块的目的

如何,用户如何访问系统,网络,APP,小程序等。

HOW TIME,用户访问每个模块多长时间,浏览特定页面等

以上是我们需要获取的所有数据。只有获得相关数据,我们才能分析用户行为。

用户行为数据采集掩埋点

掩埋点通常分为非掩埋点和代码掩埋点。这两个都有各自的优缺点,这里仅作简要介绍:

全掩埋点是一种前端掩埋方法。 SDK嵌入在产品中,这是最统一的掩埋点。关键行为是通过接口配置方法定义的,以完成埋入点采集,这是前端的埋入点方式之一。

优势:

缺点:

作为前端掩埋点,会有一些自然的缺点

代码掩埋点,这也是我们当前使用的掩埋方法。代码埋入点分为前端代码埋入点和后端代码埋入点。前端埋入点类似于完整埋入点,并且还需要嵌入到SDK中。区别在于对于每种事件行为,您需要调用SDK代码,传入必要的事件名称,属性参数等,然后将其发送到后台数据服务器。后端嵌入式点通过调用SDK接口的后端模块将事件和属性发送到后端服务器。

我们使用代码掩埋点,将其分为前端和后端。嵌入是一个特别重要的过程。它是数据的来源。如果数据源存在问题,则数据本身存在问题,分析结果将失去意义。

因为我负责日志检测,即埋入点之后事件日志的检测警报,并通知相应的埋入点开发人员,操作员和产品方面,所以我遇到了很多凹坑,其中大多数是过程。

事件属性具有元数据管理系统,并且行业中的某些服务也具有此结构。通常,首先定义事件和属性,然后掩埋点。原因是需要检查事件日志数据。有必要检查事件是否存在,属性是否丢失,数据是否正常等等。

遇到的坑

数据错误。这种情况很难发现。需要在操作产品的分析中找到它。这也有点不舒服

基于上述想法,让我们谈谈实现的相关技术问题以及如何进行用户行为分析。

数据采集

根据操作定义的嵌入式点接口形式获取的用户访问日志数据,必须预先在后端和前端定义数据存储格式,即字段内容为保存,并且嵌入点数据需要符合协议。格式统一并封装起来,以便于存储和分析。

以下数据采集神器Flume已耗尽。

实时掩埋点数据采集通常有两种方法:

直接触发的日志将发送到指定的HTTP端口,并写入kafka,然后Flume将kafka消耗到HDFS用户访问日志到磁盘,在相应的主机上部署flume代理,并将文件发送到采集记录目录到Kafka,然后将Flume部署到云中以将Kafka数据消耗到HDFS中

然后,Flume 采集系统的安装相对简单,只需两个步骤:

flume配置模板:

a1.sources = source1

a1.sinks = k1

a1.channels = c1

a1.sources.source1.type = org.apache.flume.source.kafka.KafkaSource

a1.sources.source1.channels = c1

a1.sources.source1.kafka.bootstrap.servers = kafka-host1:port1,kafka-host2:port2...

a1.sources.source1.kafka.topics = flume-test

a1.sources.source1.kafka.consumer.group.id = flume-test-group

# Describe the sink

a1.sinks.k1.type = hdfs

a1.sinks.k1.hdfs.path = /tmp/flume/test-data

a1.sinks.k1.hdfs.fileType=DataStream

# Use a channel which buffers events in memory

a1.channels.c1.type = memory

a1.channels.c1.capacity = 100

a1.channels.c1.transactionCapacity = 100

# Bind the source and sink to the channel

a1.sources.source1.channels = c1

a1.sinks.k1.channel = c1

解决方案:广州美图图片采集神器服务为先

采集交流 • 优采云 发表了文章 • 0 个评论 • 328 次浏览 • 2020-09-04 22:21

广州美图采集神器服务至上

因此,在科学技术日新月异的时代,全图水印的去除越来越困难,例如随机位置。一些新闻,摄影和其他行业需要大量的图片,时间紧迫。选择Morning Domain专业水印去除软件。速度快,效果好,受到了客户的好评。

广州美图采集神器服务至上

我的朋友问Chenyudata 采集器是否可以采集图片,我当然可以。每个人可能都使用过晨域数据采集器批处理采集 文章数据,但是有时我们还需要采集一些图片,我们也可以使用晨域数据采集器来完成,方法是同样,这也非常简单。下面将介绍使用早晨域图片采集器 采集瀑布流网站图片的方法(以首页图片采集为例)。

水印类别识别算法可以通过程序区分和识别图片水印的不同类别,从而减轻了人工对水印进行分类的麻烦。识别准确率一般在99%左右,也就是说,千张图片中只有几张不能被准确识别。难以识别的单个水印的识别准确率也达到95%以上。

早晨域网站 采集系统针对不同行业的用户的应用需求,目的是访问Internet,并在用户定义的规则下从Internet获得指定的网站信息。获取的信息可以存储在数据库中,也可以直接发送到指定的列,以实现网站信息的及时更新和数据量的增加。

对于特定种类的水印,需要花一些时间来编写删除算法以达到最佳效果,然后分批删除它。与PS不同,请不要在几分钟后查看效果图。由于需要编写删除算法,因此仅接受超过1000页的项目。

广州美图Picture 采集神器服务是第一项。由于大量的图像处理要求以及Photoshop手动水印的复杂性和低效率,Chenyu Software Studio自20年来一直致力于研究图像算法和批量水印。解。批量水印程序主要包括一些算法,水印去除算法,水印类别识别算法和水印随机位置识别算法。

为图片加水印使外行倍感困扰。从理论上讲可以处理PS,但是如果图片数量较大且工作时间相对紧张,则不适合使用。 Meitu Elimination Pen适用于一些相对简单且不麻烦的处理,但无法实现复杂水印或图片的所需效果。为了解决上述问题,晨宇公司进行了研究,实现了++程序的批处理去除水印,实现了无痕与快速去除的完美结合。 查看全部

广州美图采集神器服务至上

广州美图采集神器服务至上

因此,在科学技术日新月异的时代,全图水印的去除越来越困难,例如随机位置。一些新闻,摄影和其他行业需要大量的图片,时间紧迫。选择Morning Domain专业水印去除软件。速度快,效果好,受到了客户的好评。

广州美图采集神器服务至上

我的朋友问Chenyudata 采集器是否可以采集图片,我当然可以。每个人可能都使用过晨域数据采集器批处理采集 文章数据,但是有时我们还需要采集一些图片,我们也可以使用晨域数据采集器来完成,方法是同样,这也非常简单。下面将介绍使用早晨域图片采集器 采集瀑布流网站图片的方法(以首页图片采集为例)。

水印类别识别算法可以通过程序区分和识别图片水印的不同类别,从而减轻了人工对水印进行分类的麻烦。识别准确率一般在99%左右,也就是说,千张图片中只有几张不能被准确识别。难以识别的单个水印的识别准确率也达到95%以上。

早晨域网站 采集系统针对不同行业的用户的应用需求,目的是访问Internet,并在用户定义的规则下从Internet获得指定的网站信息。获取的信息可以存储在数据库中,也可以直接发送到指定的列,以实现网站信息的及时更新和数据量的增加。

对于特定种类的水印,需要花一些时间来编写删除算法以达到最佳效果,然后分批删除它。与PS不同,请不要在几分钟后查看效果图。由于需要编写删除算法,因此仅接受超过1000页的项目。

广州美图Picture 采集神器服务是第一项。由于大量的图像处理要求以及Photoshop手动水印的复杂性和低效率,Chenyu Software Studio自20年来一直致力于研究图像算法和批量水印。解。批量水印程序主要包括一些算法,水印去除算法,水印类别识别算法和水印随机位置识别算法。

为图片加水印使外行倍感困扰。从理论上讲可以处理PS,但是如果图片数量较大且工作时间相对紧张,则不适合使用。 Meitu Elimination Pen适用于一些相对简单且不麻烦的处理,但无法实现复杂水印或图片的所需效果。为了解决上述问题,晨宇公司进行了研究,实现了++程序的批处理去除水印,实现了无痕与快速去除的完美结合。

解决方案:浙江怎么采集神器服务至上

采集交流 • 优采云 发表了文章 • 0 个评论 • 356 次浏览 • 2020-09-03 21:53

浙江采集神器如何首先服务

晨宇提供数据和图片批处理采集服务,并可以根据客户要求定制采集程序,批量保存指定的网站文字信息,图片和视频,并以目录和文件格式存储由客户指定。客户无需学习任何软件操作。他们只需要提出特定的数据要求并等待成品数据。数据采集程序将检查采集的数据和图片,以确保没有丢失的重复项和错误,并且提交给客户的数据是正确,完整且不可重复的。

浙江采集神器如何首先服务

除了去除图像水印外,该公司还提供诸如整个站点数据采集图像批处理采集视频水印去除等服务。我们的长期合作客户包括服装,鞋子,帽子,行李箱,手表,电子产品,工业用品,交通运输,房地产采集和其他行业。

近年来,我们已经处理了一百多个网站图像水印,包括单水印去除,多水印去除,全图像水印去除,多种水印去除,单水印位置随机,多水印位置随机,情况复杂,效果好,时间短,价格低廉,赢得了客户的好评。

浙江采集人工制品服务是至高无上的,因为分批添加了许多水印,水印是相似的,因此可以分批删除早晨域中各种水印的研究和测试,结果是肯定的。 Chenyu开发了一种通用的多图像抠像算法。输入带水印的图片时,它可以自动确定图像的“前景”(水印)遮罩和“背景”(原创图像),从而完美地去除和恢复图像。原创图像的颜色和图案。

近年来,随着科学技术的飞速发展,越来越多的人开始意识到,因此,通常我们在社交软件中看到的图片或视频都会带有水印。如果要添加这些内容,则将保存图片或视频,但是看到水印可能不是特别好。此时,您要删除水印吗?如何快速删除水印?

浙江采集伪影服务是至高无上的,图片批处理水印软件使用混沌序列算法,该算法不仅易于生成水印特征,而且具有对初始条件敏感的优势。由于嵌入检测和提取水印的特征,混沌序列算法的初始值更加简单实用。根据混沌序列脱水算法的这些优点,混沌序列直接用作提取的水印信号。根据混沌对初始值的敏感性和混沌伪随机序列的可靠性,分别使用两种不同的混沌映射模型提取和去除水印图像,以提高批量水印的效果和效率。 查看全部

浙江采集神器如何首先服务

浙江采集神器如何首先服务

晨宇提供数据和图片批处理采集服务,并可以根据客户要求定制采集程序,批量保存指定的网站文字信息,图片和视频,并以目录和文件格式存储由客户指定。客户无需学习任何软件操作。他们只需要提出特定的数据要求并等待成品数据。数据采集程序将检查采集的数据和图片,以确保没有丢失的重复项和错误,并且提交给客户的数据是正确,完整且不可重复的。

浙江采集神器如何首先服务

除了去除图像水印外,该公司还提供诸如整个站点数据采集图像批处理采集视频水印去除等服务。我们的长期合作客户包括服装,鞋子,帽子,行李箱,手表,电子产品,工业用品,交通运输,房地产采集和其他行业。

近年来,我们已经处理了一百多个网站图像水印,包括单水印去除,多水印去除,全图像水印去除,多种水印去除,单水印位置随机,多水印位置随机,情况复杂,效果好,时间短,价格低廉,赢得了客户的好评。

浙江采集人工制品服务是至高无上的,因为分批添加了许多水印,水印是相似的,因此可以分批删除早晨域中各种水印的研究和测试,结果是肯定的。 Chenyu开发了一种通用的多图像抠像算法。输入带水印的图片时,它可以自动确定图像的“前景”(水印)遮罩和“背景”(原创图像),从而完美地去除和恢复图像。原创图像的颜色和图案。

近年来,随着科学技术的飞速发展,越来越多的人开始意识到,因此,通常我们在社交软件中看到的图片或视频都会带有水印。如果要添加这些内容,则将保存图片或视频,但是看到水印可能不是特别好。此时,您要删除水印吗?如何快速删除水印?

浙江采集伪影服务是至高无上的,图片批处理水印软件使用混沌序列算法,该算法不仅易于生成水印特征,而且具有对初始条件敏感的优势。由于嵌入检测和提取水印的特征,混沌序列算法的初始值更加简单实用。根据混沌序列脱水算法的这些优点,混沌序列直接用作提取的水印信号。根据混沌对初始值的敏感性和混沌伪随机序列的可靠性,分别使用两种不同的混沌映射模型提取和去除水印图像,以提高批量水印的效果和效率。

干货教程:Python 网络爬虫实战

采集交流 • 优采云 发表了文章 • 0 个评论 • 239 次浏览 • 2020-08-31 20:21

Python是一种清晰,功能强大的面向对象的编程语言,广泛用于Web开发,GUI开发,科学计算和其他领域.

本课程首先介绍采集器的概念,应用和分类,以及数据获取方法和数据的作用;然后说明如何使用Python语言的内置urllib模块来实现小型爬网程序,并详细说明urllib模块的用法,包括发送请求的请求,处理异常的错误以及解析以处理URL;然后介绍了易于使用的请求库,包括其优点和用法;最后说明了Scrapy数据采集框架和XPath进行数据分析的用法,以及如何使用Selenium和Chrome无头模式来抓取动态网页.

[课程目标]

了解爬虫的概念和功能

使用urllib,Requests,Scrapy等编写Web采集器程序

[适用对象]

业务,开发,学生,Python爬网初学者,Python爬网爱好者

[课程大纲]

知识模块

简介

Python网络抓取工具实战

什么是爬虫,如何在“人工智能时代”获取数据,爬虫在生活中,爬虫的数据有什么用,为什么要用Python编写爬虫,对爬虫进行分类,使用urllib来实现最小化爬虫程序,urllib用法的基础知识,人性化的请求,神奇的正则表达式,数据采集工件: Scrapy,数据分析工件: xpath,动态网页的死敌: Selenium和Chromeheadless 查看全部

Python网络抓取工具实战

Python是一种清晰,功能强大的面向对象的编程语言,广泛用于Web开发,GUI开发,科学计算和其他领域.

本课程首先介绍采集器的概念,应用和分类,以及数据获取方法和数据的作用;然后说明如何使用Python语言的内置urllib模块来实现小型爬网程序,并详细说明urllib模块的用法,包括发送请求的请求,处理异常的错误以及解析以处理URL;然后介绍了易于使用的请求库,包括其优点和用法;最后说明了Scrapy数据采集框架和XPath进行数据分析的用法,以及如何使用Selenium和Chrome无头模式来抓取动态网页.

[课程目标]

了解爬虫的概念和功能

使用urllib,Requests,Scrapy等编写Web采集器程序

[适用对象]

业务,开发,学生,Python爬网初学者,Python爬网爱好者

[课程大纲]

知识模块

简介

Python网络抓取工具实战

什么是爬虫,如何在“人工智能时代”获取数据,爬虫在生活中,爬虫的数据有什么用,为什么要用Python编写爬虫,对爬虫进行分类,使用urllib来实现最小化爬虫程序,urllib用法的基础知识,人性化的请求,神奇的正则表达式,数据采集工件: Scrapy,数据分析工件: xpath,动态网页的死敌: Selenium和Chromeheadless

自动发布信息软件 网站全手动发贴利器 可靠

采集交流 • 优采云 发表了文章 • 0 个评论 • 175 次浏览 • 2020-08-26 09:25

自动发布信息软件 网站全手动发贴利器 可靠

百度不收录?各平台批量删掉封号?

自动发布信息软件一款完全取代手工,实现全手动发布信息的软件!自动切换标题、内容、图片等。保证每晚条发布的信息都不相同。原创度更高,百度,360,搜狗等各大搜索引擎更快抓取!迅速上百度首页!

乐推手动发布软件软件的特性: 自动发布信息软件,产品推广软件,自动发布软件,自动发贴器,发布软件编撰脚本不需要任何语言基础,看懂字,听懂话的人都能编撰,您可能常常光顾一些峰会。

自动插入全省城市名和任意结尾词,与标题相对应的内容,自动上传图片,可以无数语句组合成不同的原创内容,只要你发好站,秒收!

自动发布信息软件它-能给您带来:排名好,业务多,客户多,信息多;,售后服务:软件只是一个工具,我们提供这样一个集你们之校长的工具

自动发布信息软件 网站全手动发贴利器 可靠

自动发布信息软件支持任意网站发布信息的软件-随意发企业信息助手,人工发布信息的疗效一定比群发软件效果好,因为百度更新之后,对重复信息早已完全屏蔽,包括发布时间十分接近的类似信息也是不收录的,因为人工不可能1秒钟之内发布上千条信息,软件可任意指定本地图片,可对图片,批量更改大小,尺寸,批量添加文字图片水印,也可直接批量采集外链图片,批量保存本地,也可直接调阅外链地址!

自动发布信息软件 网站全手动发贴利器 可靠

自动发布信息软件支持复制整个网站脚本和一键克隆动作,拥有发贴所有需用到的功能,软件运行至今,无一例封号,因为是完全模拟人工发布信息,你不用害怕任何封号的可能随便发-企业信息助手软件完全可以解决你的苦恼。

人工发布信息的疗效一定比群发软件效果好,因为百度更新之后,对重复信息早已完全屏蔽,包括发布时间十分接近的类似信息也是不收录的,因为人工不可能1秒钟之内发布上千条信息,您可能也想过自己假如能编撰一款发布软件该多好,这样任何网路平台都是您推广产品的好地方,只要您有产品或是有服务,只要您想在网路上布满您的产品信息,那么选择我们手动发布信息软件吧,你是否烦恼订购的群发软件久久不去更新,你是否烦恼订购的软件不能满足自己的需求,可以找我们客服团队或去我们的峰会提出你所须要的功能,随意订制出自己心意的成效,软件可以设定完成任务自动关机,您可以在夜晚手动使笔记本发布而无须工作人员在场工作,且可依据自身网路来设置发贴子的速率。

欢迎来到深圳市创变网络有限公司网站, 具体地址是航城工业区富鑫林工业园1栋202,联系人是梁小姐。 查看全部

自动发布信息软件 网站全手动发贴利器 可靠

自动发布信息软件 网站全手动发贴利器 可靠

百度不收录?各平台批量删掉封号?

自动发布信息软件一款完全取代手工,实现全手动发布信息的软件!自动切换标题、内容、图片等。保证每晚条发布的信息都不相同。原创度更高,百度,360,搜狗等各大搜索引擎更快抓取!迅速上百度首页!

乐推手动发布软件软件的特性: 自动发布信息软件,产品推广软件,自动发布软件,自动发贴器,发布软件编撰脚本不需要任何语言基础,看懂字,听懂话的人都能编撰,您可能常常光顾一些峰会。

自动插入全省城市名和任意结尾词,与标题相对应的内容,自动上传图片,可以无数语句组合成不同的原创内容,只要你发好站,秒收!

自动发布信息软件它-能给您带来:排名好,业务多,客户多,信息多;,售后服务:软件只是一个工具,我们提供这样一个集你们之校长的工具

自动发布信息软件 网站全手动发贴利器 可靠

自动发布信息软件支持任意网站发布信息的软件-随意发企业信息助手,人工发布信息的疗效一定比群发软件效果好,因为百度更新之后,对重复信息早已完全屏蔽,包括发布时间十分接近的类似信息也是不收录的,因为人工不可能1秒钟之内发布上千条信息,软件可任意指定本地图片,可对图片,批量更改大小,尺寸,批量添加文字图片水印,也可直接批量采集外链图片,批量保存本地,也可直接调阅外链地址!

自动发布信息软件 网站全手动发贴利器 可靠

自动发布信息软件支持复制整个网站脚本和一键克隆动作,拥有发贴所有需用到的功能,软件运行至今,无一例封号,因为是完全模拟人工发布信息,你不用害怕任何封号的可能随便发-企业信息助手软件完全可以解决你的苦恼。

人工发布信息的疗效一定比群发软件效果好,因为百度更新之后,对重复信息早已完全屏蔽,包括发布时间十分接近的类似信息也是不收录的,因为人工不可能1秒钟之内发布上千条信息,您可能也想过自己假如能编撰一款发布软件该多好,这样任何网路平台都是您推广产品的好地方,只要您有产品或是有服务,只要您想在网路上布满您的产品信息,那么选择我们手动发布信息软件吧,你是否烦恼订购的群发软件久久不去更新,你是否烦恼订购的软件不能满足自己的需求,可以找我们客服团队或去我们的峰会提出你所须要的功能,随意订制出自己心意的成效,软件可以设定完成任务自动关机,您可以在夜晚手动使笔记本发布而无须工作人员在场工作,且可依据自身网路来设置发贴子的速率。

欢迎来到深圳市创变网络有限公司网站, 具体地址是航城工业区富鑫林工业园1栋202,联系人是梁小姐。

不懂代码也能爬取数据?我们推荐这6款利器

采集交流 • 优采云 发表了文章 • 0 个评论 • 179 次浏览 • 2020-08-25 23:34

先谈谈获取数据的方法:一是借助现成的工具,我们只需懂得怎样使用工具能够获取数据,不需要关心工具是如何实现。打个比方,假如我们在岸上,要去海上某个小岛,岸边有一艘船,我们第一看法是选择乘船过去,而不会想着自己来造一艘船再过去。

第二种是自己针对场景需求做些多样化工具,这就须要有点编程基础。举个事例,我们还是要到海上某个小岛,同时还要求在 30 分钟内将 1 顿货物送到岛上。

因此,前期只是单纯想获取数据,没有哪些其他要求的话,优先选择现有工具。

可能是 Python 近来年太火,加上我们会常常听到他人用 Python 来制做网路爬虫抓取数据。从而有一些朋友有这样的误区,想从网路上抓取数据就一定要学 Python,一定要去写代码。

其实不然,本文介绍几个能快速获取网上数据的工具。

01 Microsoft Excel

你没有看错,就是 Office 三剑客之一的 Excel。Excel 是一个强悍的工具,能抓取数据就是它的功能之一。我以麦克风作为关键字,抓取易迅的商品列表。

等待几秒后,Excel 会将页面上所有的文字信息抓取到表格中。这种方法确实能抓取到数据,但也会引入一些我们不需要的数据。如果你有更高的需求,可以选择前面几个工具。

02 优采云采集器

优采云是爬虫界的老品牌了,是目前使用人数最多的互联网数据抓取、处理、分析、挖掘软件。它的优势是采集不限网页,不限内容,同时还是分布式采集,效率会高一些。缺点是对小白用户不是太友好,有一定的知识门槛(了解如网页知识、HTTP 协议等方面知识),还须要花些时间熟悉工具操作。

因为有学习门槛,掌握该工具以后,采集数据上限会很高。有时间和精力的朋友可以去折腾折腾。

官网地址:

03 优采云采集器

优采云采集器是一款十分适宜菜鸟的采集器。它具有简单易用的特性,让你能几分钟中就快手上手。优采云提供一些常见抓取网站的模板,使用模板能够快速抓取数据。如果想抓取没有模板的网站,官网也提供十分详尽的图文教程和视频教程。

优采云是基于浏览器内核实现可视化抓取数据,所以存在卡顿、采集数据慢的特性。但这瑕不掩瑜,能基本满足菜鸟在短时间抓取数据的场景,比如翻页查询,Ajax 动态加载数据等。

网站:

04 GooSeeker 集搜客

集搜客也是一款容易上手的可视化采集数据工具。同样能抓取动态网页,也支持可以抓取手机网站上的数据,还支持抓取在指数图表上漂浮显示的数据。集搜客是以浏览器插件方式抓取数据。虽然具有上面所述的有点,但缺点也有,无法多线程采集数据,出现浏览器卡顿也在所难免。

网站:

05 Scrapinghub

如果你想抓取美国的网站数据,可以考虑 Scrapinghub。Scrapinghub 是一个基于Python 的 Scrapy 框架的云爬虫平台。Scrapehub 算是市场上十分复杂和强悍的网路抓取平台,提供数据抓取的解决方案商。

地址:

06 WebScraper

WebScraper 是一款优秀国内的浏览器插件。同样也是一款适宜菜鸟抓取数据的可视化工具。我们通过简单设置一些抓取规则,剩下的就交给浏览器去工作。

地址: 查看全部

不懂代码也能爬取数据?我们推荐这6款利器

先谈谈获取数据的方法:一是借助现成的工具,我们只需懂得怎样使用工具能够获取数据,不需要关心工具是如何实现。打个比方,假如我们在岸上,要去海上某个小岛,岸边有一艘船,我们第一看法是选择乘船过去,而不会想着自己来造一艘船再过去。

第二种是自己针对场景需求做些多样化工具,这就须要有点编程基础。举个事例,我们还是要到海上某个小岛,同时还要求在 30 分钟内将 1 顿货物送到岛上。

因此,前期只是单纯想获取数据,没有哪些其他要求的话,优先选择现有工具。

可能是 Python 近来年太火,加上我们会常常听到他人用 Python 来制做网路爬虫抓取数据。从而有一些朋友有这样的误区,想从网路上抓取数据就一定要学 Python,一定要去写代码。

其实不然,本文介绍几个能快速获取网上数据的工具。

01 Microsoft Excel

你没有看错,就是 Office 三剑客之一的 Excel。Excel 是一个强悍的工具,能抓取数据就是它的功能之一。我以麦克风作为关键字,抓取易迅的商品列表。

等待几秒后,Excel 会将页面上所有的文字信息抓取到表格中。这种方法确实能抓取到数据,但也会引入一些我们不需要的数据。如果你有更高的需求,可以选择前面几个工具。

02 优采云采集器

优采云是爬虫界的老品牌了,是目前使用人数最多的互联网数据抓取、处理、分析、挖掘软件。它的优势是采集不限网页,不限内容,同时还是分布式采集,效率会高一些。缺点是对小白用户不是太友好,有一定的知识门槛(了解如网页知识、HTTP 协议等方面知识),还须要花些时间熟悉工具操作。

因为有学习门槛,掌握该工具以后,采集数据上限会很高。有时间和精力的朋友可以去折腾折腾。

官网地址:

03 优采云采集器

优采云采集器是一款十分适宜菜鸟的采集器。它具有简单易用的特性,让你能几分钟中就快手上手。优采云提供一些常见抓取网站的模板,使用模板能够快速抓取数据。如果想抓取没有模板的网站,官网也提供十分详尽的图文教程和视频教程。

优采云是基于浏览器内核实现可视化抓取数据,所以存在卡顿、采集数据慢的特性。但这瑕不掩瑜,能基本满足菜鸟在短时间抓取数据的场景,比如翻页查询,Ajax 动态加载数据等。

网站:

04 GooSeeker 集搜客

集搜客也是一款容易上手的可视化采集数据工具。同样能抓取动态网页,也支持可以抓取手机网站上的数据,还支持抓取在指数图表上漂浮显示的数据。集搜客是以浏览器插件方式抓取数据。虽然具有上面所述的有点,但缺点也有,无法多线程采集数据,出现浏览器卡顿也在所难免。

网站:

05 Scrapinghub

如果你想抓取美国的网站数据,可以考虑 Scrapinghub。Scrapinghub 是一个基于Python 的 Scrapy 框架的云爬虫平台。Scrapehub 算是市场上十分复杂和强悍的网路抓取平台,提供数据抓取的解决方案商。

地址:

06 WebScraper

WebScraper 是一款优秀国内的浏览器插件。同样也是一款适宜菜鸟抓取数据的可视化工具。我们通过简单设置一些抓取规则,剩下的就交给浏览器去工作。

地址:

Flume 海量日志搜集神器

采集交流 • 优采云 发表了文章 • 0 个评论 • 218 次浏览 • 2020-08-25 02:33

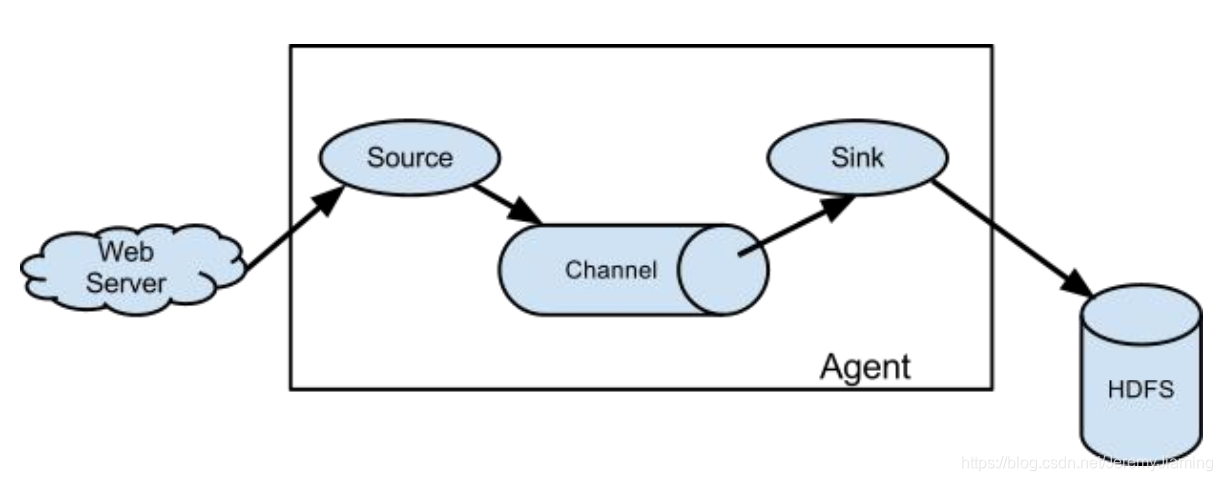

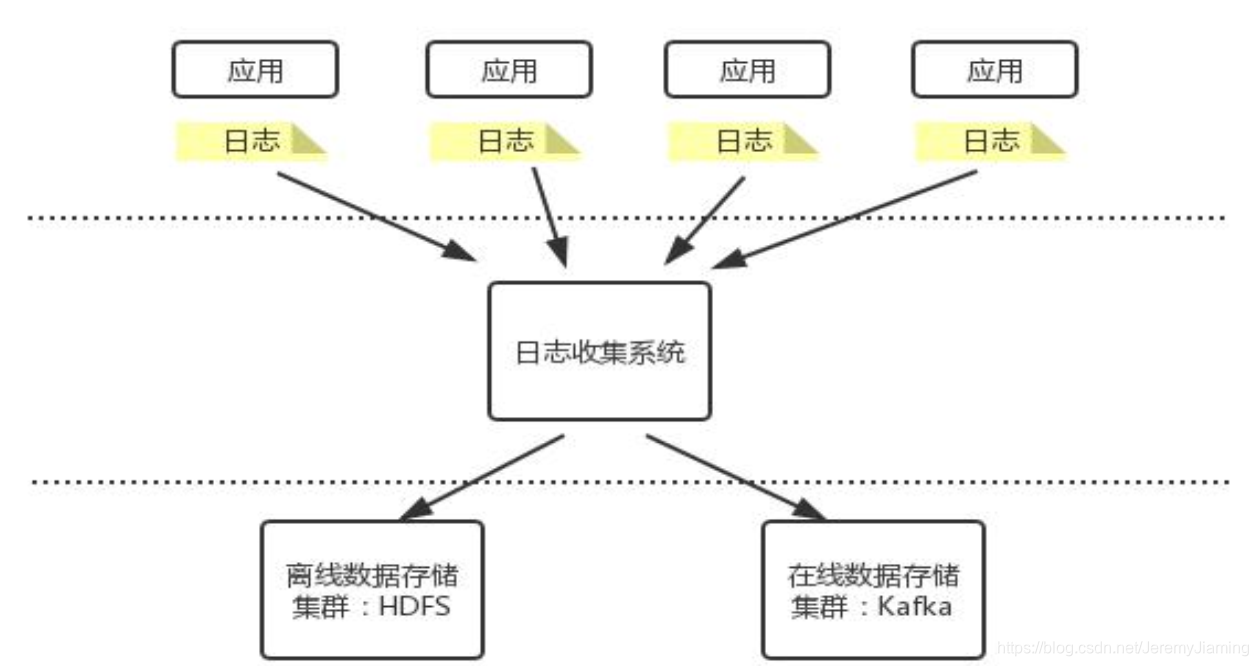

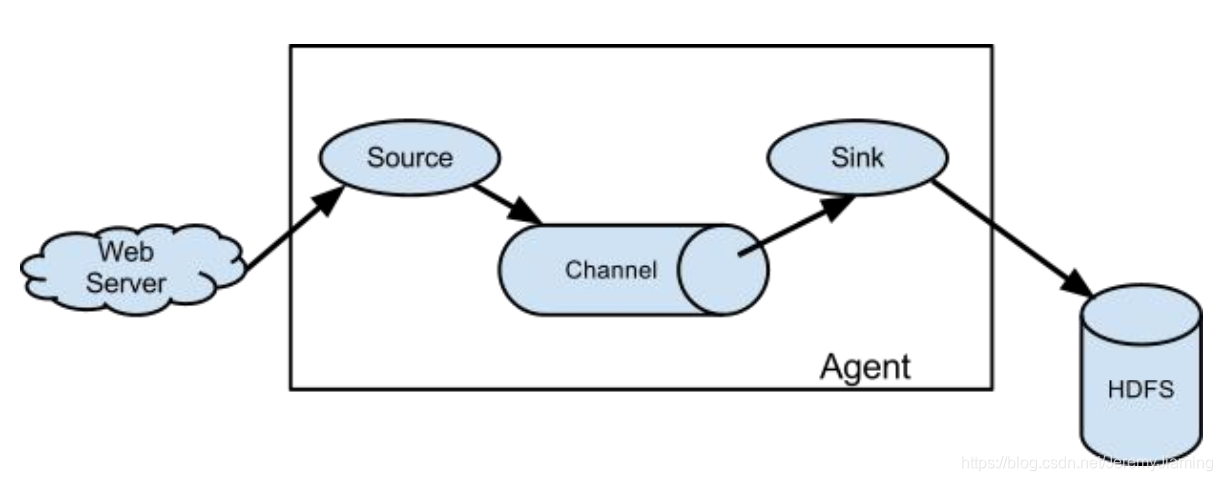

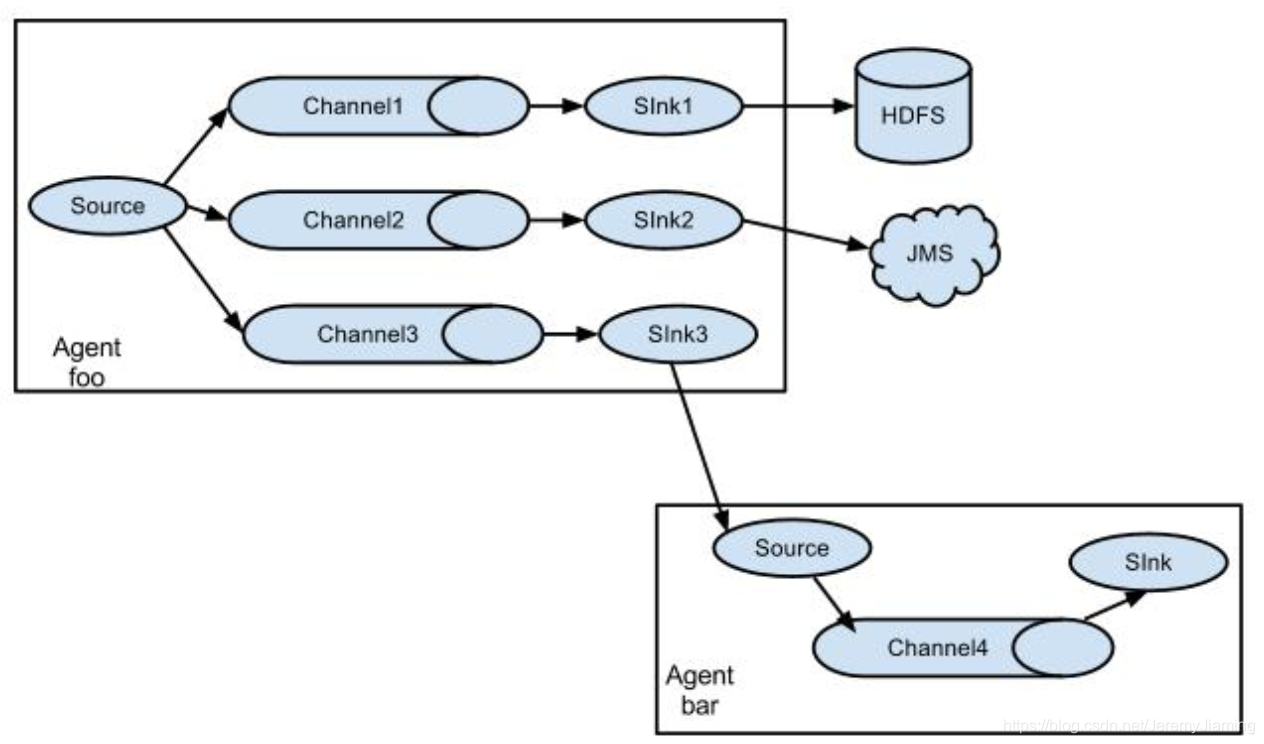

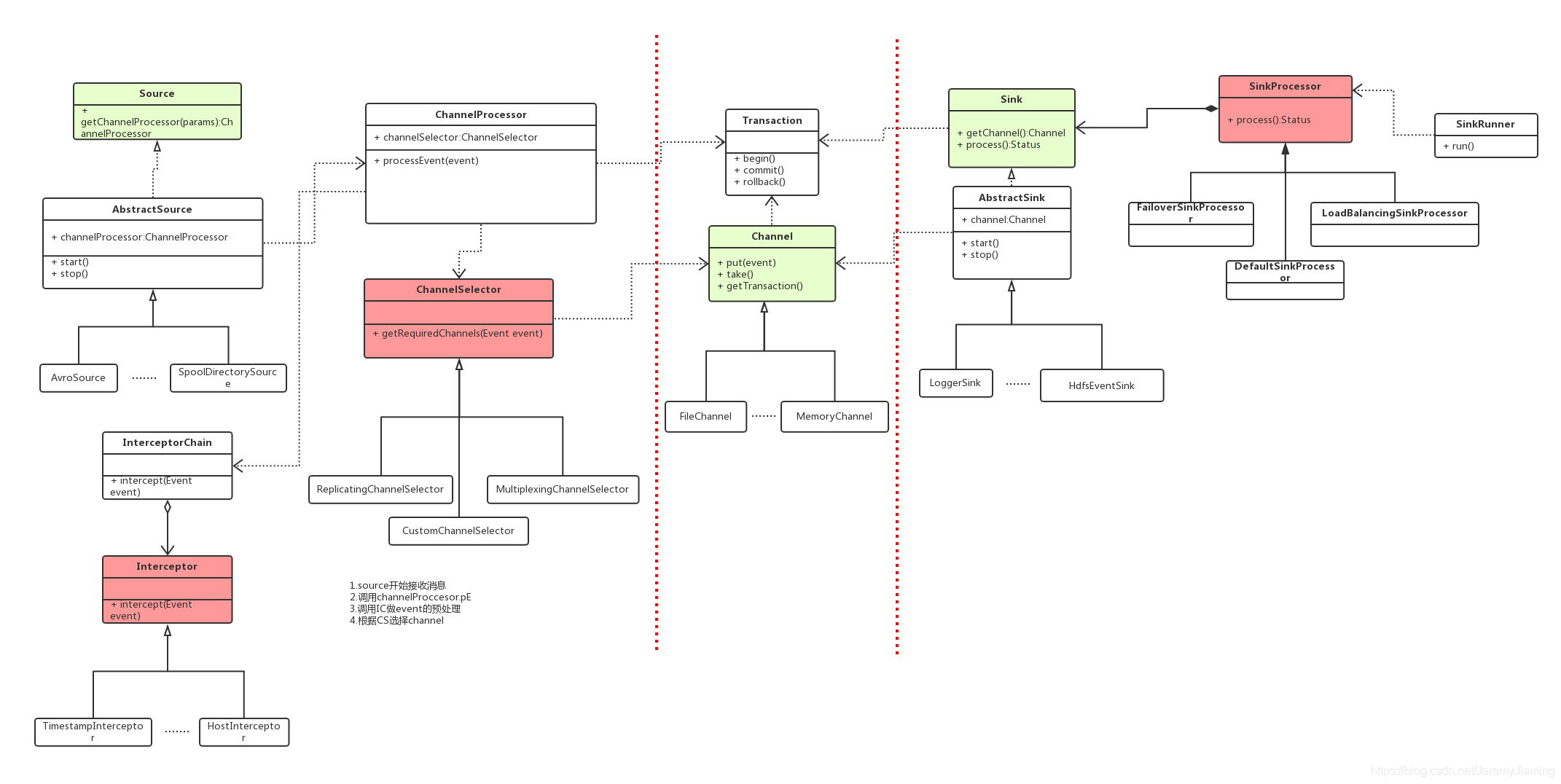

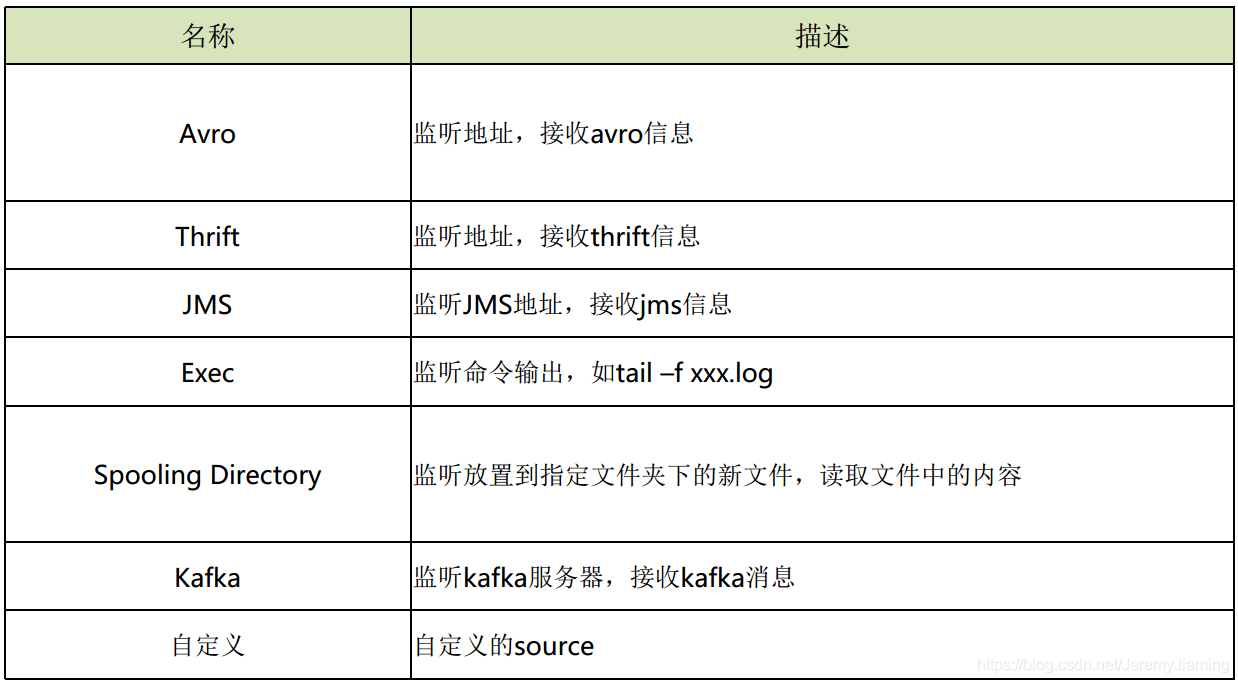

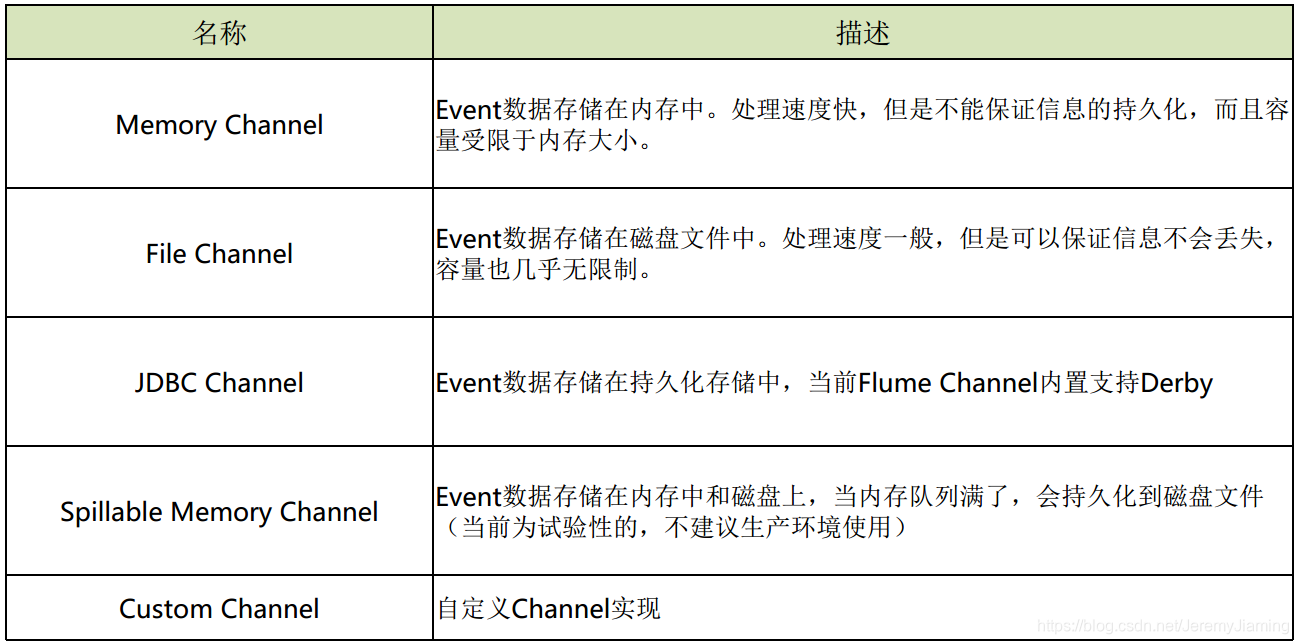

Flume 海量日志搜集神器关于日志搜集服务器日志搜集基于服务器日志的应用服务器日志的特征:日志采集系统的通常构架

日志采集系统的设计要求Flume简介是哪些?

一个高可用的、高可靠的、分布式的海量日志采集、聚合和传输的系统。Cloudera公司出品。

角色

版本Flume OG(original generation,2009年7月):分布式日志搜集系统,有Master概念,依赖于Zookeeper,分为agent,collector,storage三种角色Flume NG(next generation,2011年10月):代码构建,功能精简,去掉master,collector角色,专注数据的搜集与传递Flume组成、安装与配置组成

Flume Flow:

处理流程:

source以event为单位从数据源接收信息, 然后保存到一个或多个channel中(可以经过一个或多个interceptor的预处理) , sink从channel中拉取并处理信息(保存, 丢弃或传递到下一个agent) , 然后通知channel删掉信息。

安装

依赖:

步骤:

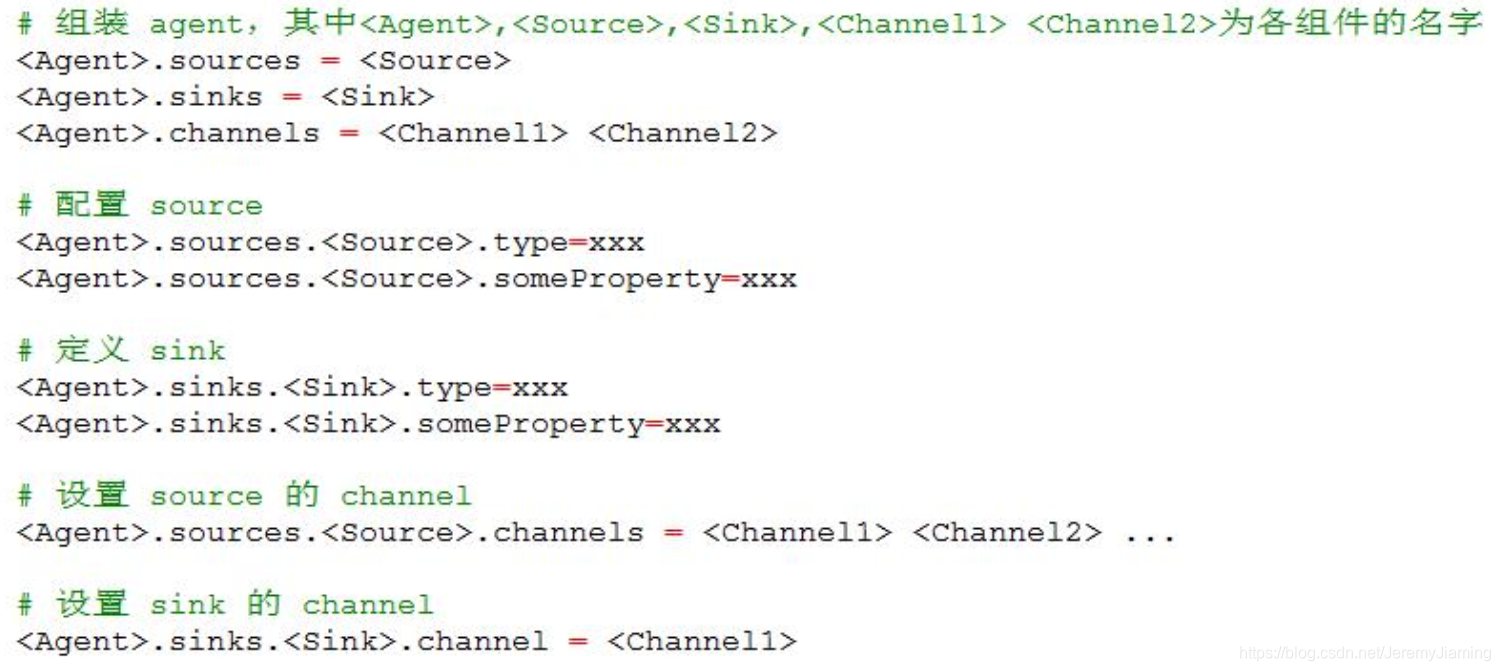

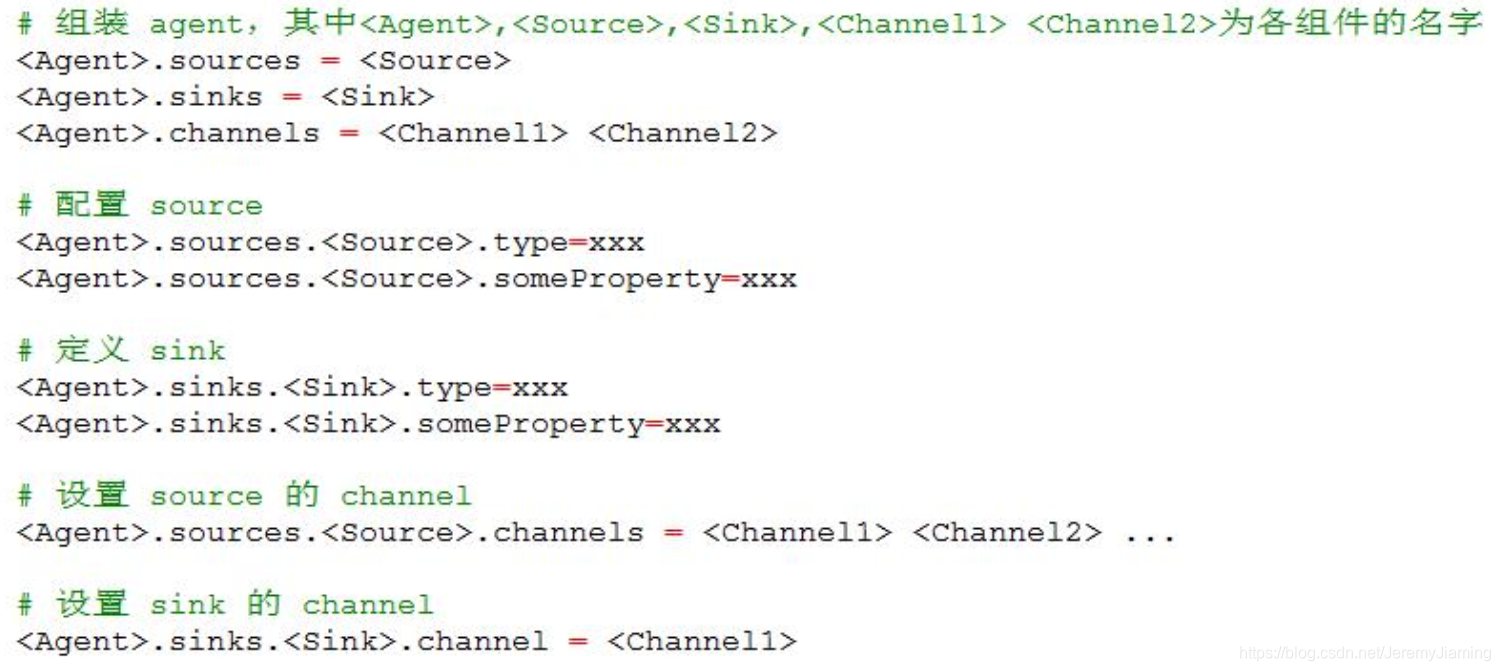

下载安装包解压配置flume-env.sh : 设置JAVA_HOME配置 agent: conf/flume-conf.properties启动: $FLUME_HOME/bin/flume-ng agent -n a1 -c conf -f xxx.properties配置模板

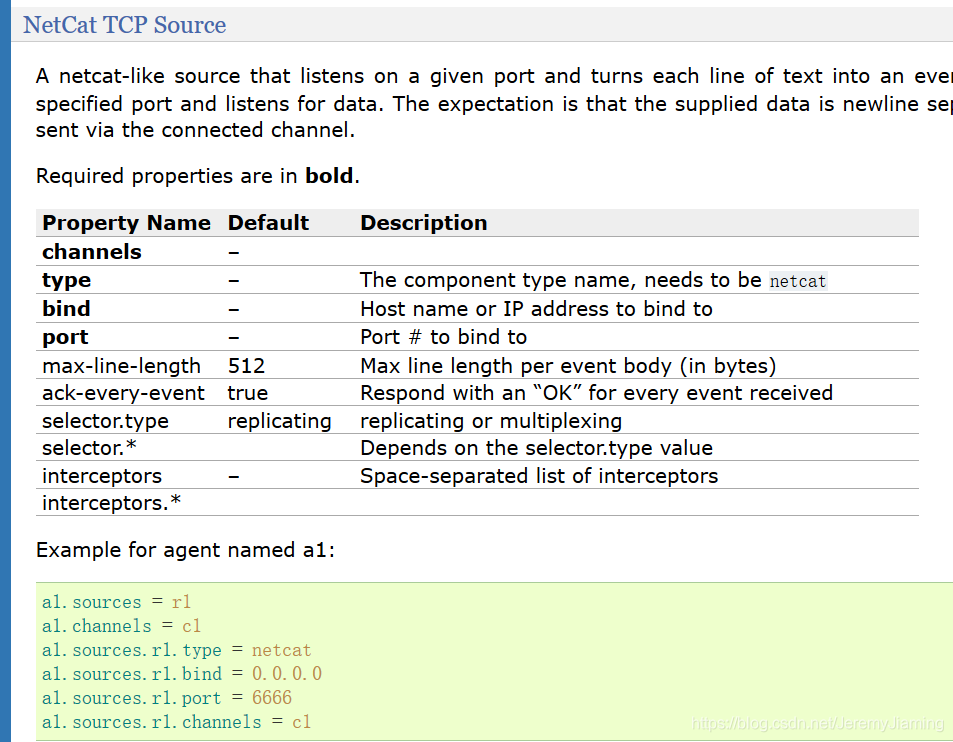

演示

具体的安装过程网上有很多,需要注意的是flume依赖的jdk为1.7及以上。但是若果linux的jdk版本不是1.7及以上也毋须更改系统的jdk,只需再度安装jdk高版本后,在flume配置文件中指定jdk高版本路径即可。

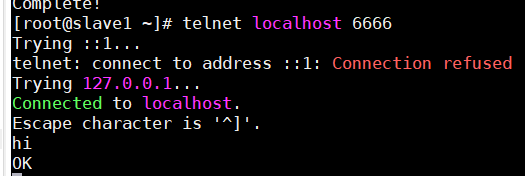

接下来,通过一个小反例,测试一下。

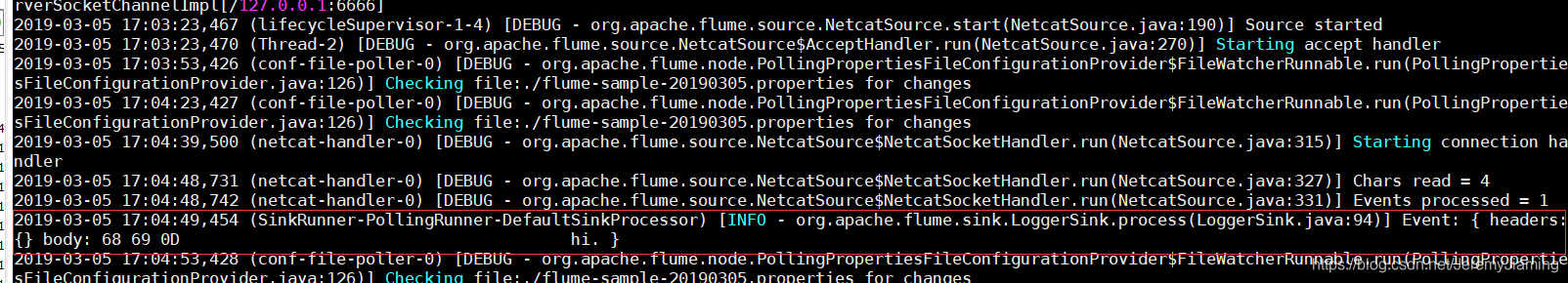

效果:

flow从指定端口获得数据,存入channel,sink从channel中拉取数据,打印输出。

分析:

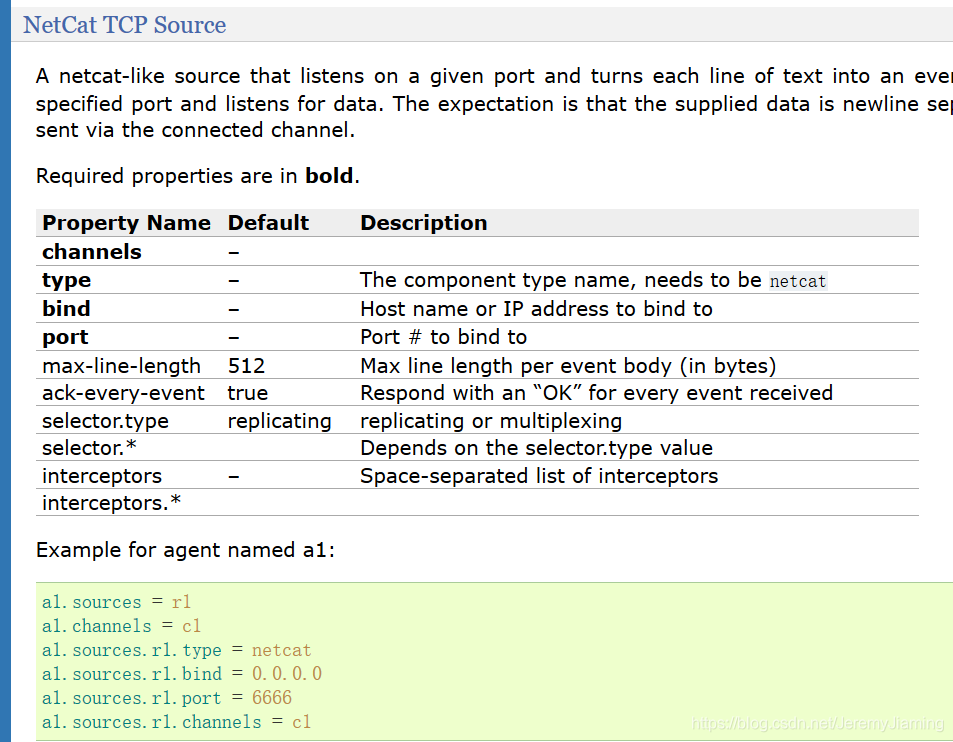

通过阅读官网document选定source、channel、sink的类型。

source选定netcat类型,其中加粗的属性为必填属性;channel选定memory类型;sink选定logger类型。

根据官网写出flume agent配置信息如下:

a1.sources = s1

a1.sinks = k1

a1.channels = c1

a1.sources.s1.type = netcat

a1.sources.s1.bind = localhost

a1.sources.s1.port = 6666

a1.sources.s1.channels = c1

a1.channels.c1.type = memory

a1.sinks.k1.type = logger

a1.sinks.k1.channel = c1

运行flume:

执行如下代码,-Dflume.root.logger=DEBUG,console 为的是将日志信息输出在命令台。

flume-ng agent -n a1 -c ./ -f ./flume-sample-20190305.properties -Dflume.root.logger=DEBUG,console

运行疗效:

执行telnet,向端口号输出‘hi’后,控制台输出以下信息,证明flume运行成功。

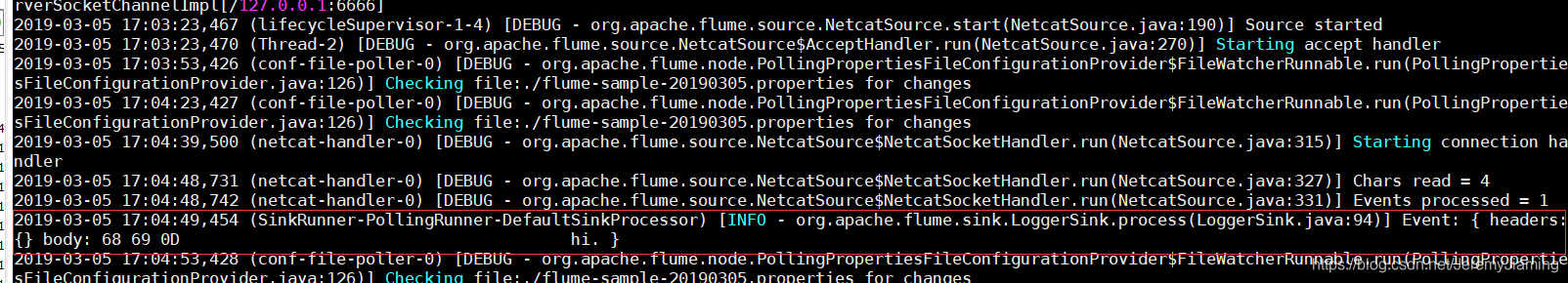

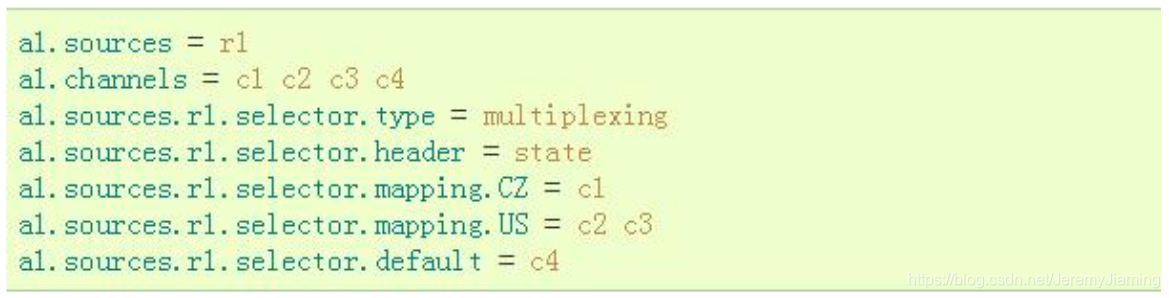

工作原理解析Flow类型

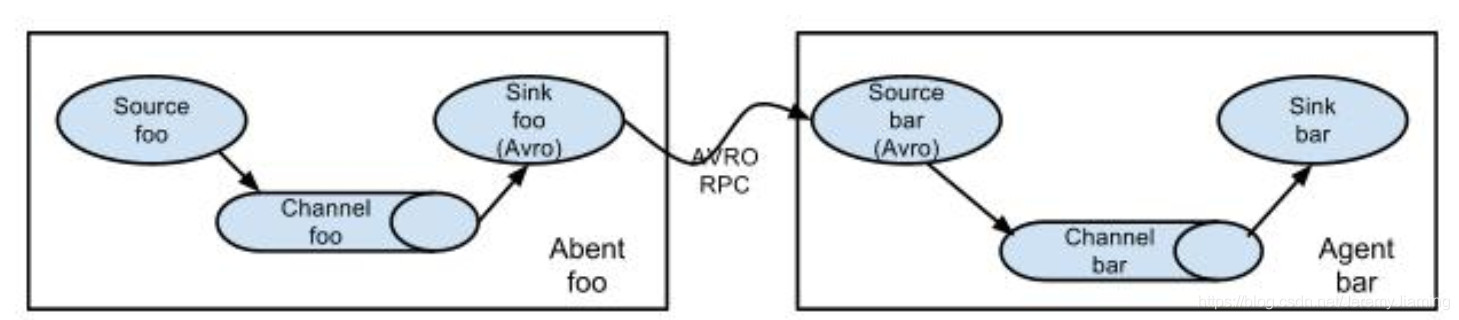

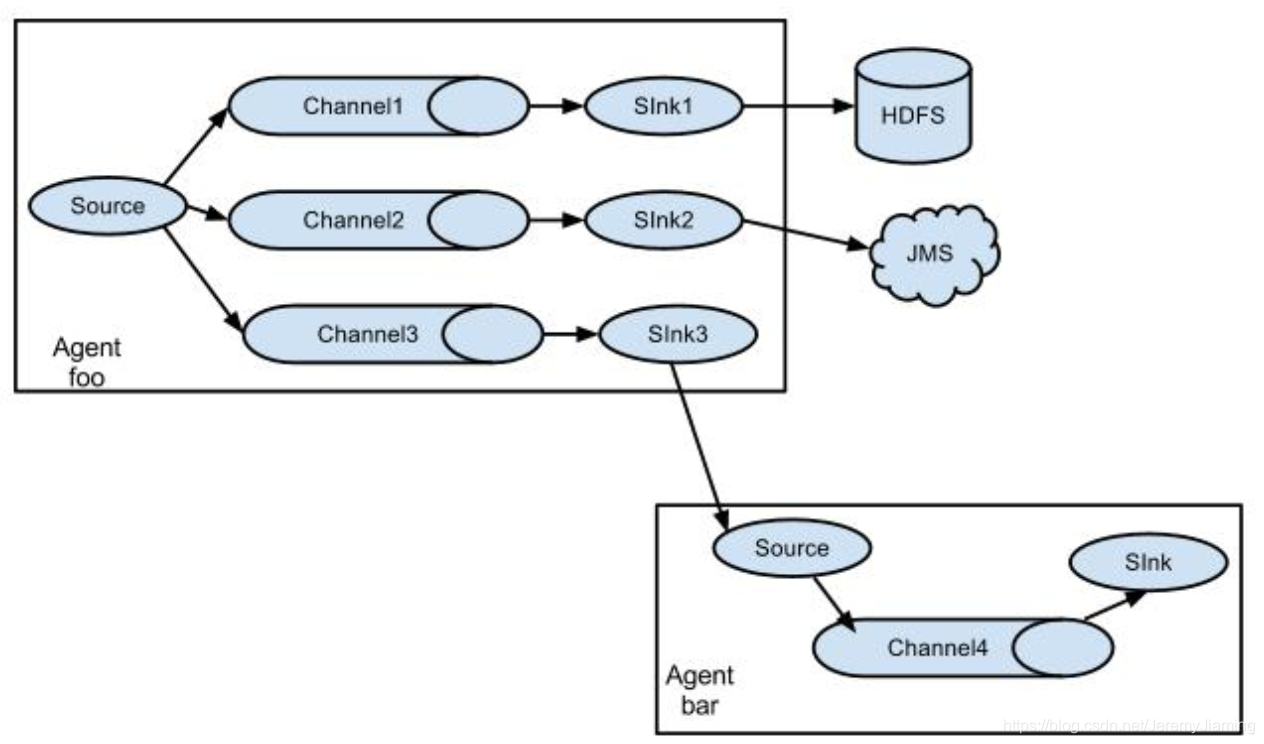

注意:一个source可以对应多个channel,而sink与channel一般是一对一的。

channel与sink一对一是因为:

假如一个channel对应多个sink,要考虑并发问题,会促使构架显得很复杂。一个channel对应一个sink后,可以按照sink的目标源的需求急迫性,为各channel分配不同大小的显存。顺序流

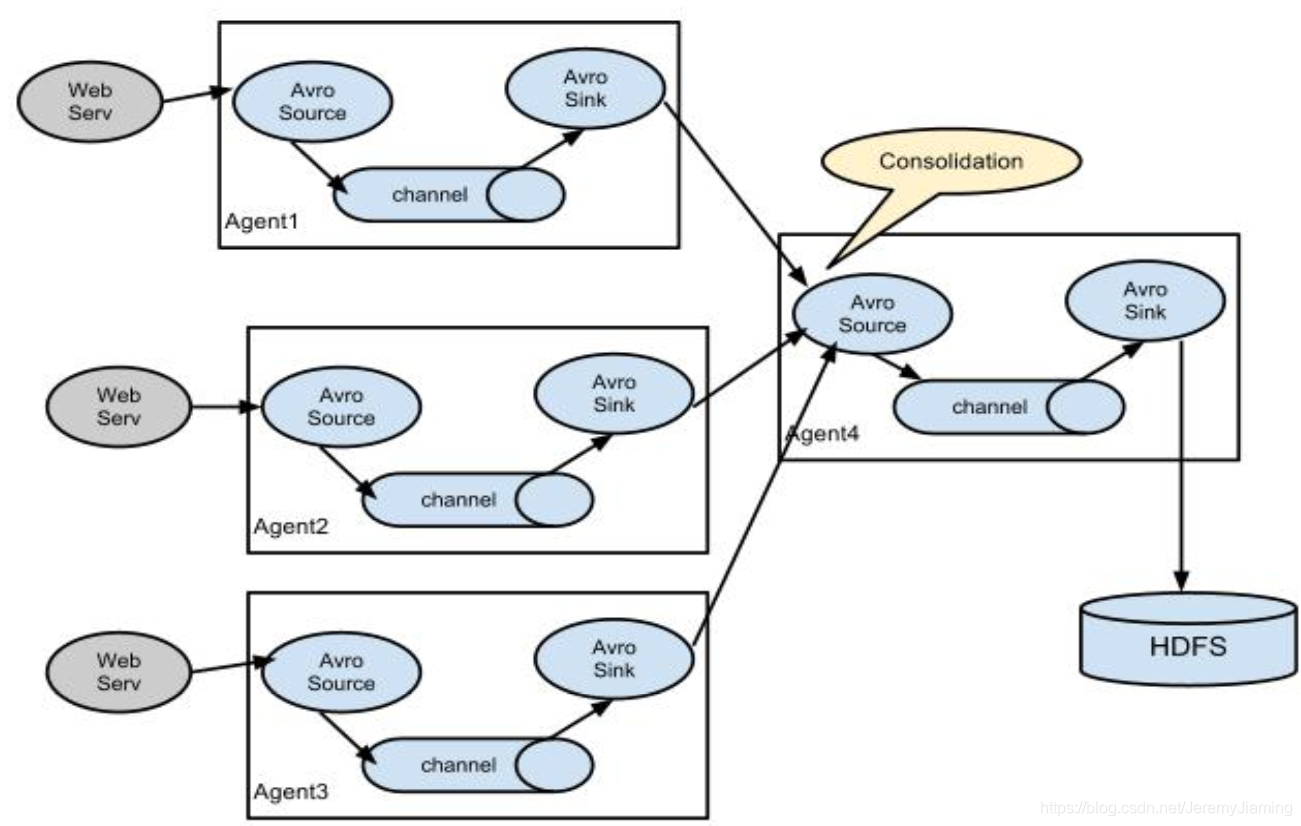

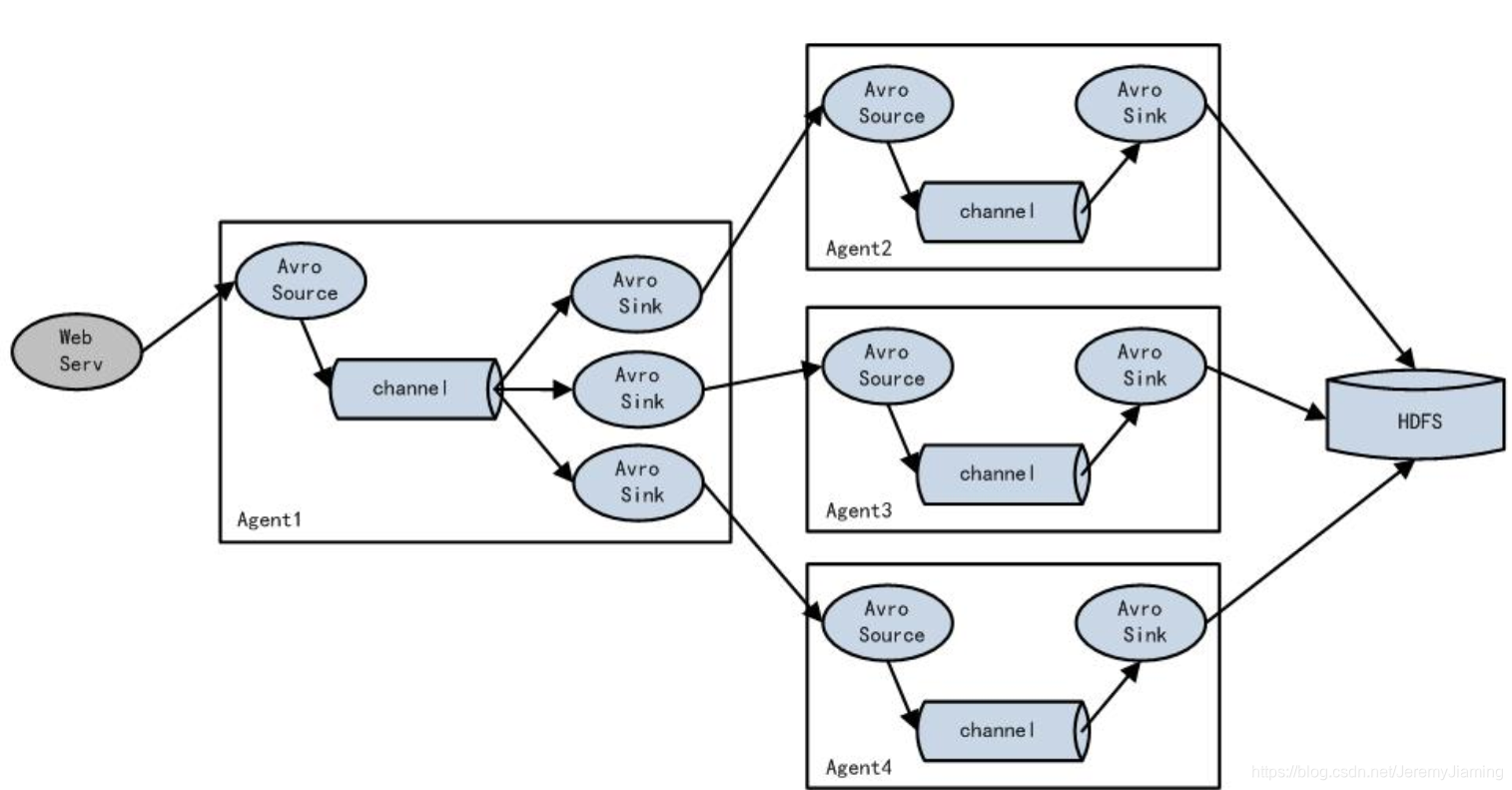

多对一聚合

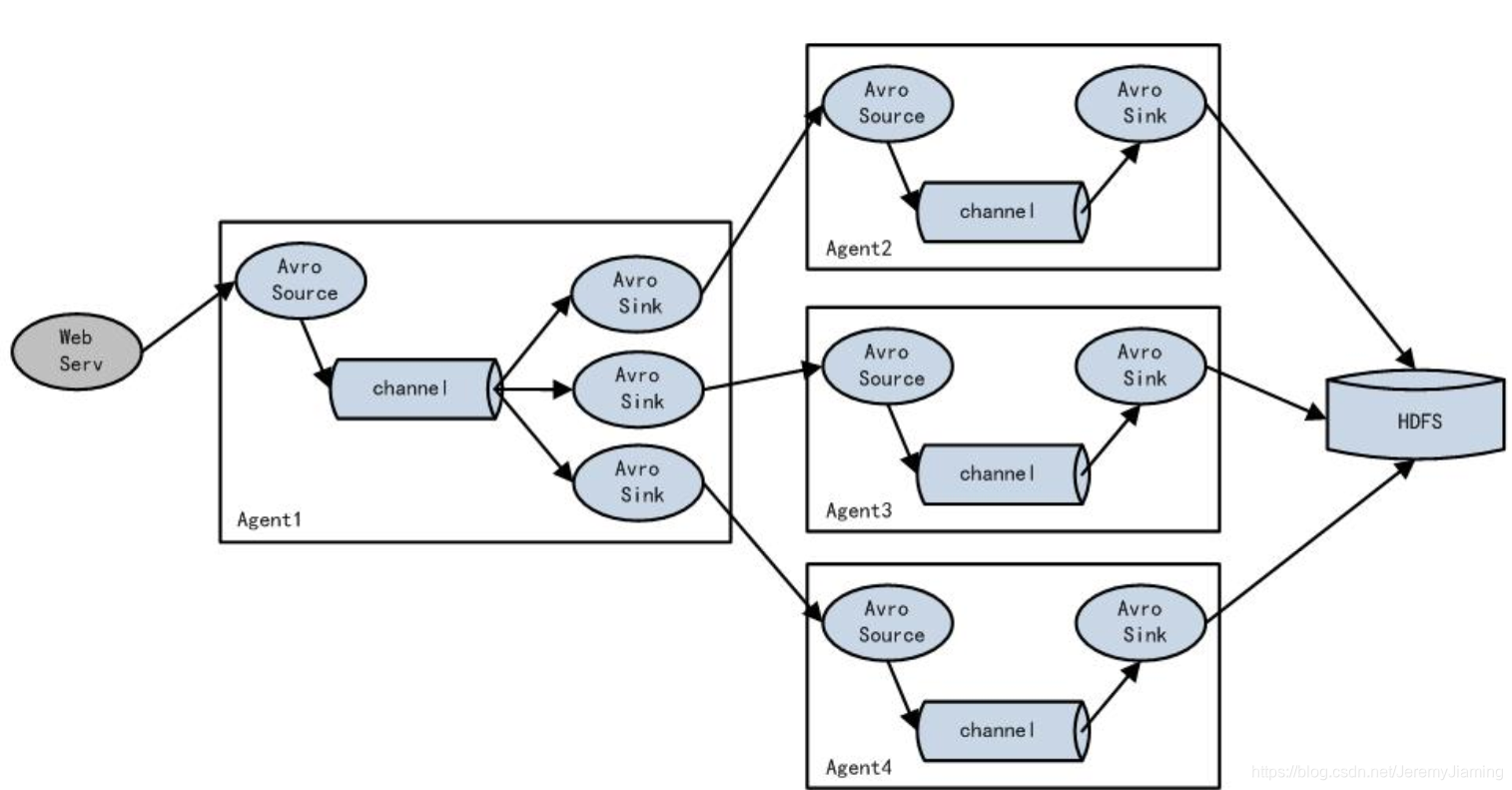

一对多路由

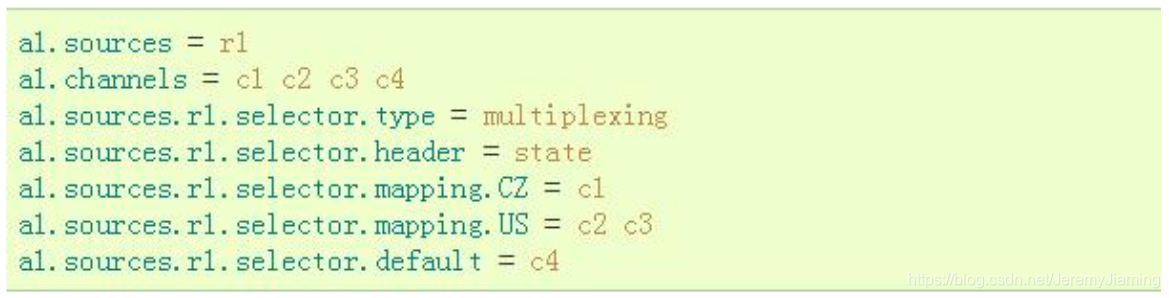

配置

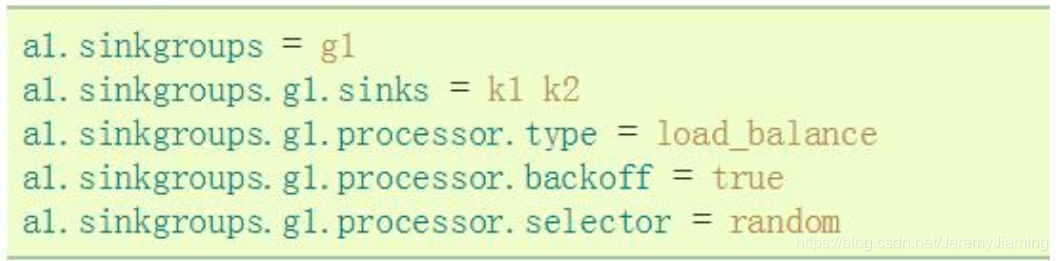

负载均衡

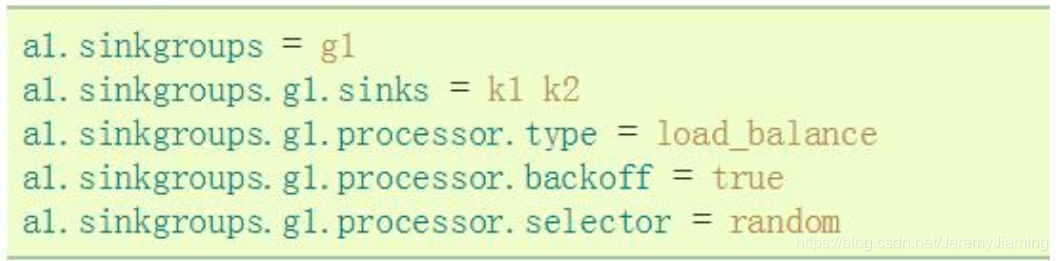

配置

工作流程source开始接收消息调用Channel Proccessor.processorEvent调用Interceptor Chain做event的预处理按照Channel Selector选择channelsink端调用Channel的take方式,获取event

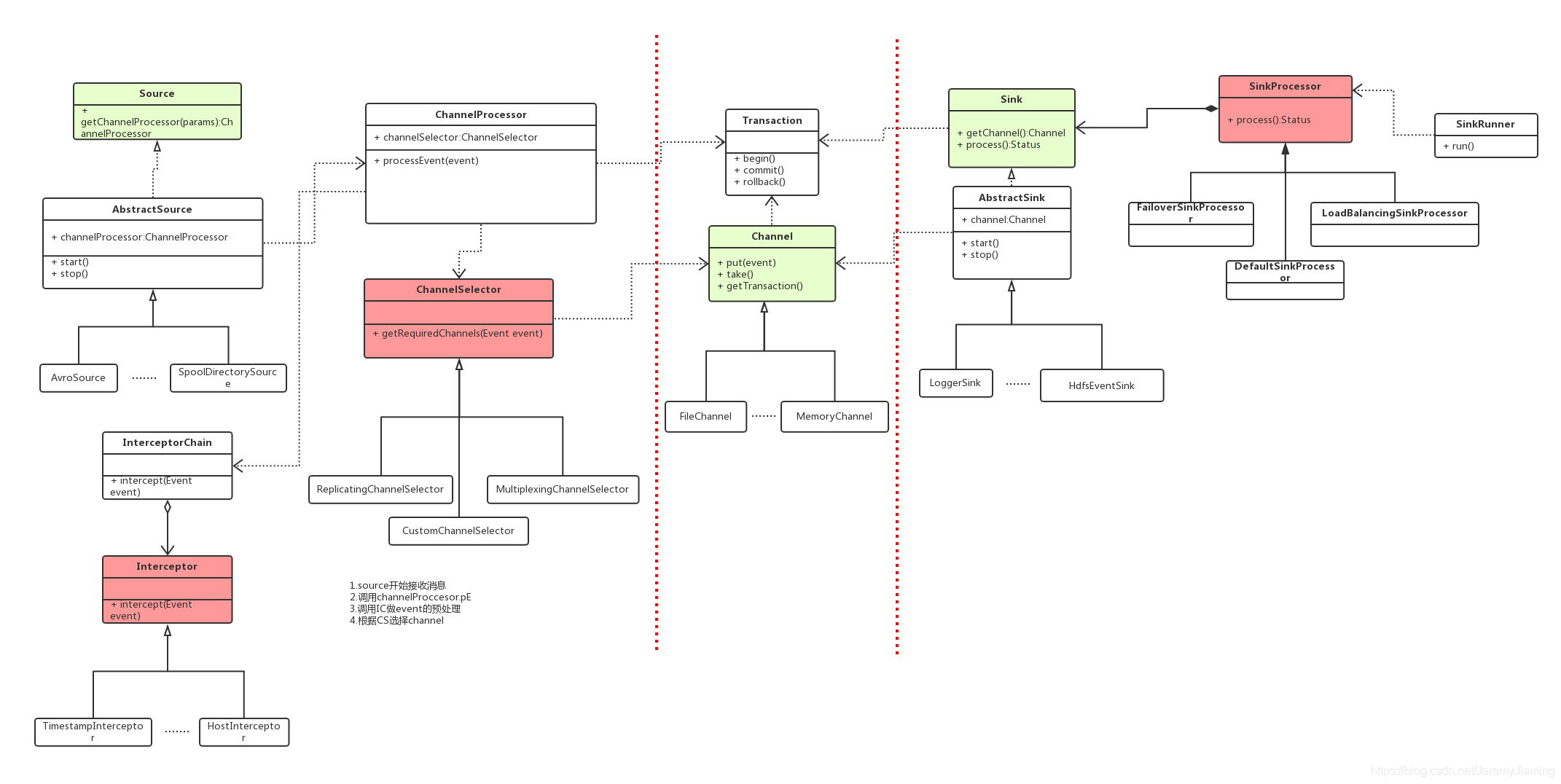

上一张Flume源码类图,可以帮助你们剖析Flume源码。

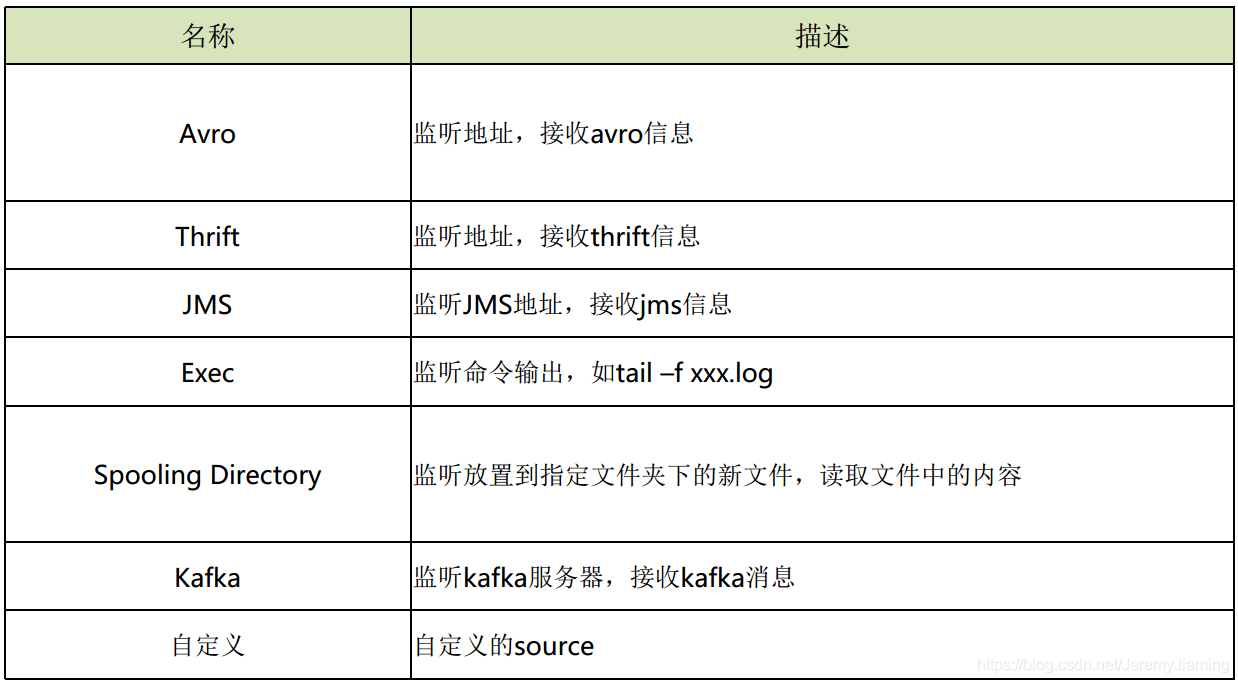

Source

Channel

Sink

常见应用场景场景一:离线日志搜集

场景描述:

采集服务器的用户访问日志,保存到Hadoop集群总,用于离线的估算与剖析。

Flume方案:

在服务器端配置flume agent, 其中:

场景二:实时日志搜集

场景描述:

采集服务器的系统日志,发送给实时估算引擎进行实时处理。

Flume方案:

在服务器端配置flume agent, 其中:

场景三:系统日志搜集

场景描述:

采集服务器的系统日志,保存到搜索引擎中,用于线上日志查询。

Flume方案:

在服务器端配置flume agent, 其中:

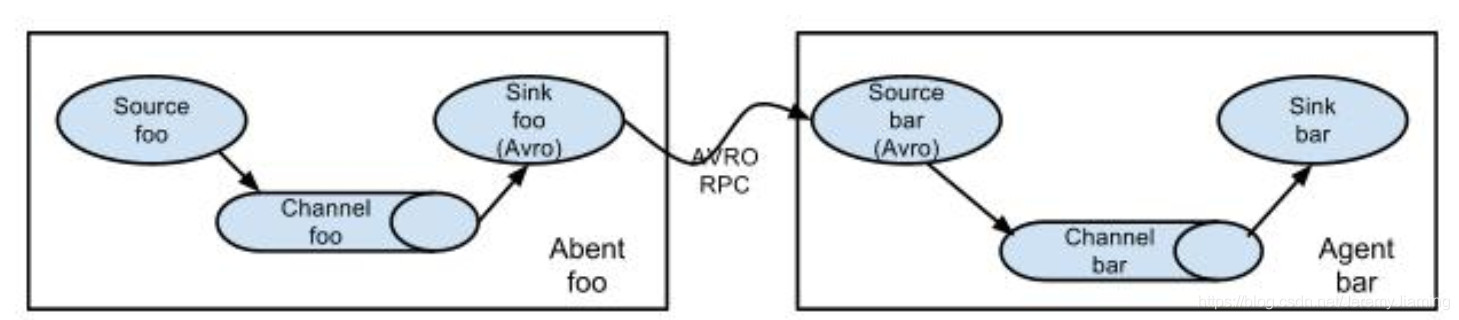

部署构架图

架构图从左至右可分为三层:

采集层、汇总层、存储层。

中间汇总到Avro Source是因为:

当储存层(HDFS,ELK)做升级和维护时,如果没有中间层,势必会在Agent层出现数据的堆积,容易导致线上系统的衰弱。相比于日志的采集来说,线上应用的正常运转更为重要。如果没有汇总层,路由就要配置到每一个Agent。实际生产中,Agent的节点数太可能上百,会给后期的路由维护带来很大麻烦。所以选择在汇总层统一配置路由信息。实例演示

我的另一篇博文:《实践:Flume同步信息到HDFS》

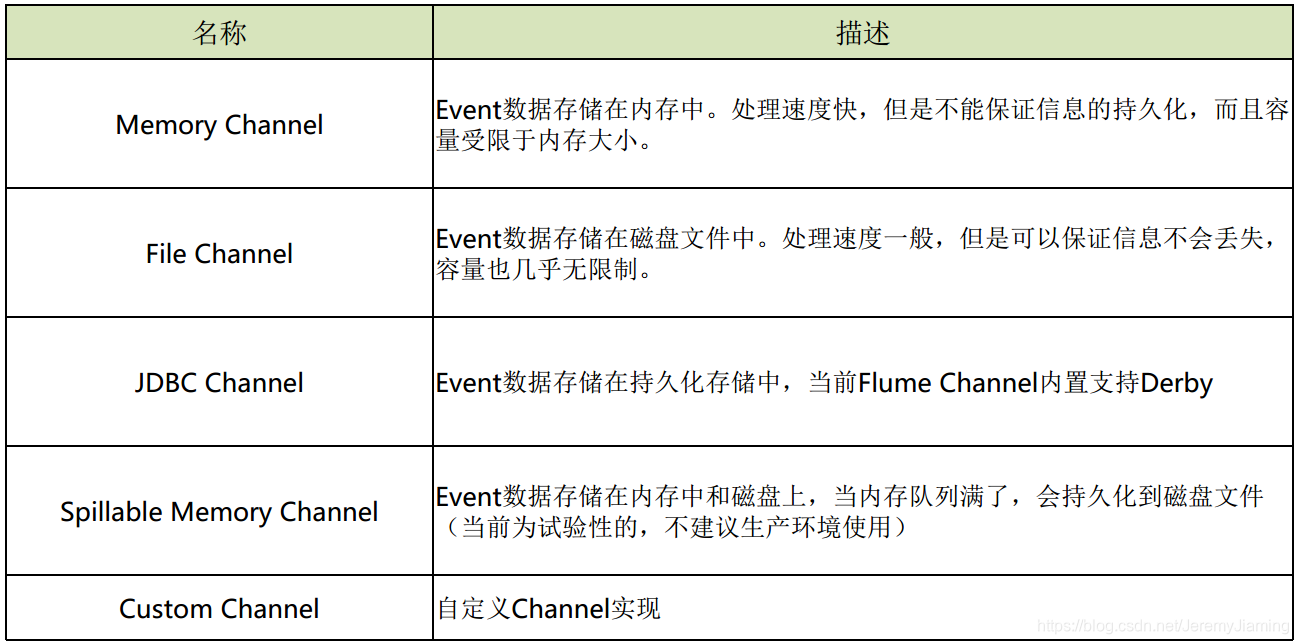

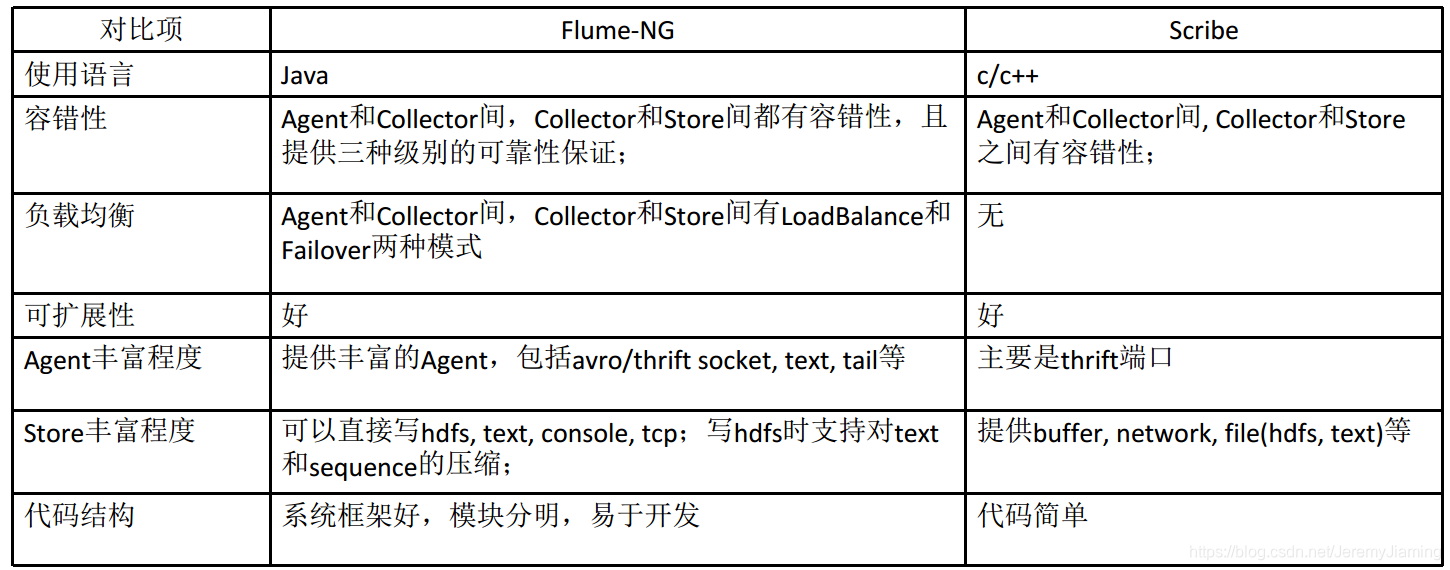

日志采集系统的设计要求其他方案Flume与Scribe对比

Flume与Kafka经验分享配置相关构架相关反省将指定目录中不断降低的日志搜集到hdfs中并测试大数据量下的收 集效率由一个agent搜集信息后发给第二个agent, 由第二个agent将信息写 入目的地同一种source源, 同一种source源,根据信息的属性(比如IP地址) 将数据发送到不 同的channel 查看全部

Flume 海量日志搜集神器

Flume 海量日志搜集神器关于日志搜集服务器日志搜集基于服务器日志的应用服务器日志的特征:日志采集系统的通常构架

日志采集系统的设计要求Flume简介是哪些?

一个高可用的、高可靠的、分布式的海量日志采集、聚合和传输的系统。Cloudera公司出品。

角色

版本Flume OG(original generation,2009年7月):分布式日志搜集系统,有Master概念,依赖于Zookeeper,分为agent,collector,storage三种角色Flume NG(next generation,2011年10月):代码构建,功能精简,去掉master,collector角色,专注数据的搜集与传递Flume组成、安装与配置组成

Flume Flow:

处理流程:

source以event为单位从数据源接收信息, 然后保存到一个或多个channel中(可以经过一个或多个interceptor的预处理) , sink从channel中拉取并处理信息(保存, 丢弃或传递到下一个agent) , 然后通知channel删掉信息。

安装

依赖:

步骤:

下载安装包解压配置flume-env.sh : 设置JAVA_HOME配置 agent: conf/flume-conf.properties启动: $FLUME_HOME/bin/flume-ng agent -n a1 -c conf -f xxx.properties配置模板

演示

具体的安装过程网上有很多,需要注意的是flume依赖的jdk为1.7及以上。但是若果linux的jdk版本不是1.7及以上也毋须更改系统的jdk,只需再度安装jdk高版本后,在flume配置文件中指定jdk高版本路径即可。

接下来,通过一个小反例,测试一下。

效果:

flow从指定端口获得数据,存入channel,sink从channel中拉取数据,打印输出。

分析:

通过阅读官网document选定source、channel、sink的类型。

source选定netcat类型,其中加粗的属性为必填属性;channel选定memory类型;sink选定logger类型。

根据官网写出flume agent配置信息如下:

a1.sources = s1

a1.sinks = k1

a1.channels = c1

a1.sources.s1.type = netcat

a1.sources.s1.bind = localhost

a1.sources.s1.port = 6666

a1.sources.s1.channels = c1

a1.channels.c1.type = memory

a1.sinks.k1.type = logger

a1.sinks.k1.channel = c1

运行flume:

执行如下代码,-Dflume.root.logger=DEBUG,console 为的是将日志信息输出在命令台。

flume-ng agent -n a1 -c ./ -f ./flume-sample-20190305.properties -Dflume.root.logger=DEBUG,console

运行疗效:

执行telnet,向端口号输出‘hi’后,控制台输出以下信息,证明flume运行成功。

工作原理解析Flow类型

注意:一个source可以对应多个channel,而sink与channel一般是一对一的。

channel与sink一对一是因为:

假如一个channel对应多个sink,要考虑并发问题,会促使构架显得很复杂。一个channel对应一个sink后,可以按照sink的目标源的需求急迫性,为各channel分配不同大小的显存。顺序流

多对一聚合

一对多路由

配置

负载均衡

配置

工作流程source开始接收消息调用Channel Proccessor.processorEvent调用Interceptor Chain做event的预处理按照Channel Selector选择channelsink端调用Channel的take方式,获取event

上一张Flume源码类图,可以帮助你们剖析Flume源码。

Source

Channel

Sink

常见应用场景场景一:离线日志搜集

场景描述:

采集服务器的用户访问日志,保存到Hadoop集群总,用于离线的估算与剖析。

Flume方案:

在服务器端配置flume agent, 其中:

场景二:实时日志搜集

场景描述:

采集服务器的系统日志,发送给实时估算引擎进行实时处理。

Flume方案:

在服务器端配置flume agent, 其中:

场景三:系统日志搜集

场景描述:

采集服务器的系统日志,保存到搜索引擎中,用于线上日志查询。

Flume方案:

在服务器端配置flume agent, 其中:

部署构架图

架构图从左至右可分为三层:

采集层、汇总层、存储层。

中间汇总到Avro Source是因为:

当储存层(HDFS,ELK)做升级和维护时,如果没有中间层,势必会在Agent层出现数据的堆积,容易导致线上系统的衰弱。相比于日志的采集来说,线上应用的正常运转更为重要。如果没有汇总层,路由就要配置到每一个Agent。实际生产中,Agent的节点数太可能上百,会给后期的路由维护带来很大麻烦。所以选择在汇总层统一配置路由信息。实例演示

我的另一篇博文:《实践:Flume同步信息到HDFS》

日志采集系统的设计要求其他方案Flume与Scribe对比

Flume与Kafka经验分享配置相关构架相关反省将指定目录中不断降低的日志搜集到hdfs中并测试大数据量下的收 集效率由一个agent搜集信息后发给第二个agent, 由第二个agent将信息写 入目的地同一种source源, 同一种source源,根据信息的属性(比如IP地址) 将数据发送到不 同的channel

碎片化知识搜集利器:方片搜集

采集交流 • 优采云 发表了文章 • 0 个评论 • 219 次浏览 • 2020-08-17 06:14

工具推荐

我们脑中忽然掠过一个看法,或者手机上浏览到一句金句,于是打开手机便条,赶紧记录出来,然后积攒一段时间后再进行整理,一个个复制黏贴到自己的印象笔记或则为知笔记中,整理成一系列内容。这是我们搜集碎片思索和知识的过程,包括了 发现/思考——打开记录工具——记录输入——分类——转移——整理——保存七个步骤。

但实际上,很少有人真的会完成这样的搜集步骤,甚至甚少人会养成搜集的习惯。主要有以下三个缘由:

①采集步骤繁杂

②碎片看法知识整理难度大

③记录容易遗失遗忘

我觉得用随身携带的手帐本记录是一个不错的习惯,尤其在办公场合是太合适的。但是带着那意味着须要随身带多一个本子,手写要够快够清晰,要分类整合也不容易。使用手机便条搜集则不易于后续整理。印象笔记、为知笔记等云笔记软件使用做完整记录或后续整合,不适宜做碎片化搜集。

那要怎么解决碎片化知识的问题呢?今天给你们带来一个为碎片化搜集而生的app———方片搜集。

它的使用场景

使用方片搜集进行看法搜集时,我们一般只须要打开陌陌置顶的“方片搜集”公众号,输入内容之后点击发送,内容都会手动同步到方片搜集。然后打开app,对想归于同一类的内容进行批量添加标签,或者批量合并,然后直接保存或则再发送到印象笔记。

在搜集某一主题资料时,我们可以直接阅读文章或浏览网页,对想记录的内容直接复制,然后点击通知栏的快捷方法,它就直接被搜集到方片搜集。等到所有资料都被搜集好,再打开app进行批量处理即可。

我们一开始提及的搜集零碎知识的七个步骤,方片搜集都进行了操作简化。

产品的优劣势优势

作为一款碎片化知识搜集工具,方片搜集有以下优点

劣势

方片搜集的定位是高效搜集碎片化知识,它基本解决了我们搜集碎片化知识的疼点:素材的快速搜集与整合。

但是我还把它作为一款灵感搜集工具,每当有了哪些看法或灵感,就直接搜集到方片搜集里,后续查找相关资料和观点时,也直接复制搜集进来,然后进行整合操作,基本上一篇文章的骨架就完成了。

总结 查看全部

碎片化知识搜集利器:方片搜集

工具推荐

我们脑中忽然掠过一个看法,或者手机上浏览到一句金句,于是打开手机便条,赶紧记录出来,然后积攒一段时间后再进行整理,一个个复制黏贴到自己的印象笔记或则为知笔记中,整理成一系列内容。这是我们搜集碎片思索和知识的过程,包括了 发现/思考——打开记录工具——记录输入——分类——转移——整理——保存七个步骤。

但实际上,很少有人真的会完成这样的搜集步骤,甚至甚少人会养成搜集的习惯。主要有以下三个缘由:

①采集步骤繁杂

②碎片看法知识整理难度大

③记录容易遗失遗忘

我觉得用随身携带的手帐本记录是一个不错的习惯,尤其在办公场合是太合适的。但是带着那意味着须要随身带多一个本子,手写要够快够清晰,要分类整合也不容易。使用手机便条搜集则不易于后续整理。印象笔记、为知笔记等云笔记软件使用做完整记录或后续整合,不适宜做碎片化搜集。

那要怎么解决碎片化知识的问题呢?今天给你们带来一个为碎片化搜集而生的app———方片搜集。

它的使用场景

使用方片搜集进行看法搜集时,我们一般只须要打开陌陌置顶的“方片搜集”公众号,输入内容之后点击发送,内容都会手动同步到方片搜集。然后打开app,对想归于同一类的内容进行批量添加标签,或者批量合并,然后直接保存或则再发送到印象笔记。

在搜集某一主题资料时,我们可以直接阅读文章或浏览网页,对想记录的内容直接复制,然后点击通知栏的快捷方法,它就直接被搜集到方片搜集。等到所有资料都被搜集好,再打开app进行批量处理即可。

我们一开始提及的搜集零碎知识的七个步骤,方片搜集都进行了操作简化。

产品的优劣势优势

作为一款碎片化知识搜集工具,方片搜集有以下优点

劣势

方片搜集的定位是高效搜集碎片化知识,它基本解决了我们搜集碎片化知识的疼点:素材的快速搜集与整合。

但是我还把它作为一款灵感搜集工具,每当有了哪些看法或灵感,就直接搜集到方片搜集里,后续查找相关资料和观点时,也直接复制搜集进来,然后进行整合操作,基本上一篇文章的骨架就完成了。

总结

采集神器,优采云的手动抓取策略和入库操作!

采集交流 • 优采云 发表了文章 • 0 个评论 • 460 次浏览 • 2020-08-09 08:12

采集一些好多防爬虫的网站,有个挺好用的工具:优采云...直接通过浏览器形式访问,一力破万法.

准备工作:money,花钱去优采云官网买一个月或则更长时间的会员,这样你能够搞云采集

下面,自己去抓取数据,抓取完成后,设置定时云采集

然后你点击云采集,查看数据,就会有很多数据了,,下面是,如何把这种数据搞到本地,然后定时清空

上代码:

直接通过get_group_list获取你的分组id,然后把你须要的分组id,拿到下边get_task_list中去运行,获取所有任务列表,这样你就可以循环任务列表,获取上面的数据,运行完成后,执行api的清空操作,就完事儿了

class NewsData extends Frontend{

//备注

//八爪鱼接口文档

//https://dataapi.bazhuayu.com/help#_ref_status_code

public function ins_list()

{

$task_list=$this->get_task_list();

if($task_list==false){

echo "任务列表为空";

die();

}

$NewsSource=new NewsSource();

foreach ($task_list as $k=>$v){

$task_id=$v['taskId'];//任务id

//根据任务ID调用任务相关的数据详情

echo "任务{$v['taskName']}:{$task_id}开始: ";

sleep(1);

//循环获取数据

$data=$this->get_task_data($task_id);

$ins=[];

if(empty($data)){

echo "数据为空:跳过! ";

continue;

}

//循环插入数据

foreach ($data as $k2=>$item){

$ins=[

"cate_name"=>"新闻",

"search_name"=>$item['搜索关键词'],

"title"=>$item['最新文章标题'],

"keywords"=>"",

"description"=>"",

"thumb"=>"",

"content"=>'',

"create_time_text"=>$item['时间'],

"status"=>"1",

"oldurl"=>$item['最新文章链接'],

"author"=>$item['公众号名称'],

"author_avatar"=>$item['公总号头像'],

"author_wechat"=>$item['公众号微信号'],

];

if(strlen($item['内容'])gz_str($item['内容']);

//查询是否重复

$has_id=Db::name("news_source")->where(["title"=>$ins['title']])->value("id");

if(intval($has_id)!==0){

echo "重复ID:{$has_id},标题:{$ins['title']}--标题重复,跳过! ";

continue;

}

//插入一条数据

$ins_id=Db::name("news_source")->insertGetId($ins);

echo "成功插入一条id:{$ins_id} ";

unset($ins);

}

unset($data);

//清空任务数据

$this->remove_task_data($task_id);

}

echo "执行结束!";

die();

}

public $url="https://dataapi.bazhuayu.com";

//获取token值

public function get_token(){

$token_name="bazhuayu_token";

$token_data=Cache::get($token_name);

//如果数据为空 或者 数据过期时间"xxxx..",

"grant_type"=>"password",

];

$params=http_build_query($params);

$token_json=$this->sendPost($url,$params);

$token_data=json_decode($token_json,true);

if(!isset($token_data['expires_in'])){

echo $token_json;

return false;

}

$token_data['expires_time']=$token_data['expires_in']+time();

Cache::set($token_name,$token_data,$token_data['expires_in']);

return $token_data;

}

if(!empty($token_data)){

return $token_data;

}else{

return false;

}

}

//获取header 封装token到header中

public function get_header(){

$token_data=$this->get_token();

if($token_data==false){

echo "token错误!";

die();

}else{

$header=[

"Authorization:".$token_data['token_type'].' '.$token_data["access_token"],

];

return $header;

}

}

//获取任务组 列表

public function get_group_list(){

$url="https://dataapi.bazhuayu.com/api/TaskGroup";

$header=$this->get_header();

$list=$this->sendGet($url,$header);

$list=json_decode($list,true);

var_dump($list);

}

//获取任务详情 列表

public function get_task_list(){

$group_id=2206006;//定义任务组id

$url=$this->url."/api/Task?taskGroupId=".$group_id;

$header=$this->get_header();

$list=$this->sendGet($url,$header);

$list=json_decode($list,true);

$list=isset($list['data'])?$list['data']:false;

return $list;

}

//获取任务的数据

public function get_task_data($task_id=null)

{

//$task_id="0385e312-b674-4793-9435-xxxx";

$offset=0;

$size=200;

//$url=$this->url."/api/alldata/GetDataOfTaskByOffset?taskId={$task_id}&offset={$offset}&size={$size}";

$url=$this->url."/api/notexportdata/gettop?taskId={$task_id}&size={$size}";

$header=$this->get_header();

$data=$this->sendGet($url,$header);

$data=json_decode($data,true);

if(isset($data['data']['dataList'])&&!empty($data['data']['dataList'])){

return $data['data']['dataList'];

}else{

return false;

}

}

//清空任务的数据

public function remove_task_data($task_id=null)

{

//$task_id="02be503d-4568-430b-9f15-c3511ad8e98b";

$url=$this->url."/api/task/RemoveDataByTaskId?taskId=".$task_id;

$header=$this->get_header();

$json=$this->sendPOst($url,null,$header);

var_dump($json);

echo "任务ID{$task_id}数据销毁完成!";

}

/**

* 发起请求

* @param string $url 请求地址

* @param string $data 请求数据包

* @return string 请求返回数据

*/

public function sendPost($url,$data,$header=null)

{

$curl = curl_init(); // 启动一个CURL会话

curl_setopt($curl, CURLOPT_URL, $url); // 要访问的地址

curl_setopt($curl, CURLOPT_SSL_VERIFYPEER, 0); // 对认证证书来源的检测

curl_setopt($curl, CURLOPT_SSL_VERIFYHOST, 2); // 从证书中检查SSL加密算法是否存在

if(!empty($header)){

curl_setopt($curl, CURLOPT_HTTPHEADER, $header);

curl_setopt($curl, CURLOPT_HEADER, 0);//返回response头部信息

}

curl_setopt($curl, CURLOPT_FOLLOWLOCATION, 1); // 使用自动跳转

curl_setopt($curl, CURLOPT_AUTOREFERER, 1); // 自动设置Referer

curl_setopt($curl, CURLOPT_POST, 1); // 发送一个常规的Post请求

curl_setopt($curl, CURLOPT_POSTFIELDS, $data); // Post提交的数据包

curl_setopt($curl, CURLOPT_TIMEOUT, 30); // 设置超时限制防止死循

curl_setopt($curl, CURLOPT_RETURNTRANSFER, 1); // 获取的信息以文件流的形式返回

$return_data = curl_exec($curl); // 执行操作

if (curl_errno($curl)) {

echo 'Errno'.curl_error($curl);

}

curl_close($curl); // 关键CURL会话

return $return_data; // 返回数据

}

public function sendGet($url,$header=null)

{

$curl = curl_init(); // 启动一个CURL会话

curl_setopt($curl, CURLOPT_URL, $url); // 要访问的地址

curl_setopt($curl, CURLOPT_SSL_VERIFYPEER, 0); // 对认证证书来源的检测

curl_setopt($curl, CURLOPT_SSL_VERIFYHOST, 2); // 从证书中检查SSL加密算法是否存在

curl_setopt($curl, CURLOPT_FOLLOWLOCATION, 1); // 使用自动跳转

curl_setopt($curl, CURLOPT_AUTOREFERER, 1); // 自动设置Referer

if(!empty($header)){

curl_setopt($curl, CURLOPT_HTTPHEADER, $header);

curl_setopt($curl, CURLOPT_HEADER, 0);//返回response头部信息

}

curl_setopt($curl, CURLOPT_TIMEOUT, 20); // 设置超时限制防止死循

curl_setopt($curl, CURLOPT_RETURNTRANSFER, 1); // 获取的信息以文件流的形式返回

$return_data = curl_exec($curl); // 执行操作

if (curl_errno($curl)) {

echo 'Errno'.curl_error($curl);

}

curl_close($curl); // 关键CURL会话

return $return_data; // 返回数据

}

}

城市合伙人全球招募中:

参与线下宏伟新蓝图,用业绩说话!

软件线索、软件需求,米鼠网帮你变现!

更灵活的合作模式(不限地域、不限金额、不限项目)

更高额的提成比列(提成是软件项目收益的80%)

利润的核算方法:

以平台公开招标的最低价中标价钱为基准,剩下的为收益部份,如对平台的最低中标价钱有异议,可以推荐供应商进行竞标。

义务:

1、作为城市合伙人,在该城市借助自身优势推广“米鼠网平台”,拓展乙 方所拥有的“米鼠网平台”实名认证用户和 VIP 用户

2、作为城市合伙人,在该城市借助自身优势推广“米鼠网商城”,并寻求该地域软件产品销售商,促成软件产品销售商委托乙方在“米鼠网商城”上代理销售软件产品销售商的软件产品的交易,并拓展软件产品采购用户促使与乙方的采购交易。 查看全部

#程序员工资揭榜#你做程序员几年了?月薪多少?发量还在么?>>>

采集一些好多防爬虫的网站,有个挺好用的工具:优采云...直接通过浏览器形式访问,一力破万法.

准备工作:money,花钱去优采云官网买一个月或则更长时间的会员,这样你能够搞云采集

下面,自己去抓取数据,抓取完成后,设置定时云采集

然后你点击云采集,查看数据,就会有很多数据了,,下面是,如何把这种数据搞到本地,然后定时清空

上代码:

直接通过get_group_list获取你的分组id,然后把你须要的分组id,拿到下边get_task_list中去运行,获取所有任务列表,这样你就可以循环任务列表,获取上面的数据,运行完成后,执行api的清空操作,就完事儿了

class NewsData extends Frontend{

//备注

//八爪鱼接口文档

//https://dataapi.bazhuayu.com/help#_ref_status_code

public function ins_list()

{

$task_list=$this->get_task_list();

if($task_list==false){

echo "任务列表为空";

die();

}

$NewsSource=new NewsSource();

foreach ($task_list as $k=>$v){

$task_id=$v['taskId'];//任务id

//根据任务ID调用任务相关的数据详情

echo "任务{$v['taskName']}:{$task_id}开始: ";

sleep(1);

//循环获取数据

$data=$this->get_task_data($task_id);

$ins=[];

if(empty($data)){

echo "数据为空:跳过! ";

continue;

}

//循环插入数据

foreach ($data as $k2=>$item){

$ins=[

"cate_name"=>"新闻",

"search_name"=>$item['搜索关键词'],

"title"=>$item['最新文章标题'],

"keywords"=>"",

"description"=>"",

"thumb"=>"",

"content"=>'',

"create_time_text"=>$item['时间'],

"status"=>"1",

"oldurl"=>$item['最新文章链接'],

"author"=>$item['公众号名称'],

"author_avatar"=>$item['公总号头像'],

"author_wechat"=>$item['公众号微信号'],

];

if(strlen($item['内容'])gz_str($item['内容']);

//查询是否重复

$has_id=Db::name("news_source")->where(["title"=>$ins['title']])->value("id");

if(intval($has_id)!==0){

echo "重复ID:{$has_id},标题:{$ins['title']}--标题重复,跳过! ";

continue;

}

//插入一条数据

$ins_id=Db::name("news_source")->insertGetId($ins);

echo "成功插入一条id:{$ins_id} ";

unset($ins);

}

unset($data);

//清空任务数据

$this->remove_task_data($task_id);

}

echo "执行结束!";

die();

}

public $url="https://dataapi.bazhuayu.com";

//获取token值

public function get_token(){

$token_name="bazhuayu_token";

$token_data=Cache::get($token_name);

//如果数据为空 或者 数据过期时间"xxxx..",

"grant_type"=>"password",

];

$params=http_build_query($params);

$token_json=$this->sendPost($url,$params);

$token_data=json_decode($token_json,true);

if(!isset($token_data['expires_in'])){

echo $token_json;

return false;

}

$token_data['expires_time']=$token_data['expires_in']+time();

Cache::set($token_name,$token_data,$token_data['expires_in']);

return $token_data;

}

if(!empty($token_data)){

return $token_data;

}else{

return false;

}

}

//获取header 封装token到header中

public function get_header(){

$token_data=$this->get_token();

if($token_data==false){

echo "token错误!";

die();

}else{

$header=[

"Authorization:".$token_data['token_type'].' '.$token_data["access_token"],

];

return $header;

}

}

//获取任务组 列表

public function get_group_list(){

$url="https://dataapi.bazhuayu.com/api/TaskGroup";

$header=$this->get_header();

$list=$this->sendGet($url,$header);

$list=json_decode($list,true);

var_dump($list);

}

//获取任务详情 列表

public function get_task_list(){

$group_id=2206006;//定义任务组id

$url=$this->url."/api/Task?taskGroupId=".$group_id;

$header=$this->get_header();

$list=$this->sendGet($url,$header);

$list=json_decode($list,true);

$list=isset($list['data'])?$list['data']:false;

return $list;

}

//获取任务的数据

public function get_task_data($task_id=null)

{

//$task_id="0385e312-b674-4793-9435-xxxx";

$offset=0;

$size=200;

//$url=$this->url."/api/alldata/GetDataOfTaskByOffset?taskId={$task_id}&offset={$offset}&size={$size}";

$url=$this->url."/api/notexportdata/gettop?taskId={$task_id}&size={$size}";

$header=$this->get_header();

$data=$this->sendGet($url,$header);

$data=json_decode($data,true);

if(isset($data['data']['dataList'])&&!empty($data['data']['dataList'])){

return $data['data']['dataList'];

}else{

return false;

}

}

//清空任务的数据

public function remove_task_data($task_id=null)

{

//$task_id="02be503d-4568-430b-9f15-c3511ad8e98b";

$url=$this->url."/api/task/RemoveDataByTaskId?taskId=".$task_id;

$header=$this->get_header();

$json=$this->sendPOst($url,null,$header);

var_dump($json);

echo "任务ID{$task_id}数据销毁完成!";

}

/**

* 发起请求

* @param string $url 请求地址

* @param string $data 请求数据包

* @return string 请求返回数据

*/

public function sendPost($url,$data,$header=null)

{

$curl = curl_init(); // 启动一个CURL会话

curl_setopt($curl, CURLOPT_URL, $url); // 要访问的地址

curl_setopt($curl, CURLOPT_SSL_VERIFYPEER, 0); // 对认证证书来源的检测

curl_setopt($curl, CURLOPT_SSL_VERIFYHOST, 2); // 从证书中检查SSL加密算法是否存在

if(!empty($header)){

curl_setopt($curl, CURLOPT_HTTPHEADER, $header);

curl_setopt($curl, CURLOPT_HEADER, 0);//返回response头部信息

}

curl_setopt($curl, CURLOPT_FOLLOWLOCATION, 1); // 使用自动跳转

curl_setopt($curl, CURLOPT_AUTOREFERER, 1); // 自动设置Referer

curl_setopt($curl, CURLOPT_POST, 1); // 发送一个常规的Post请求

curl_setopt($curl, CURLOPT_POSTFIELDS, $data); // Post提交的数据包

curl_setopt($curl, CURLOPT_TIMEOUT, 30); // 设置超时限制防止死循

curl_setopt($curl, CURLOPT_RETURNTRANSFER, 1); // 获取的信息以文件流的形式返回

$return_data = curl_exec($curl); // 执行操作

if (curl_errno($curl)) {

echo 'Errno'.curl_error($curl);

}

curl_close($curl); // 关键CURL会话

return $return_data; // 返回数据

}

public function sendGet($url,$header=null)

{

$curl = curl_init(); // 启动一个CURL会话

curl_setopt($curl, CURLOPT_URL, $url); // 要访问的地址

curl_setopt($curl, CURLOPT_SSL_VERIFYPEER, 0); // 对认证证书来源的检测

curl_setopt($curl, CURLOPT_SSL_VERIFYHOST, 2); // 从证书中检查SSL加密算法是否存在

curl_setopt($curl, CURLOPT_FOLLOWLOCATION, 1); // 使用自动跳转

curl_setopt($curl, CURLOPT_AUTOREFERER, 1); // 自动设置Referer

if(!empty($header)){

curl_setopt($curl, CURLOPT_HTTPHEADER, $header);

curl_setopt($curl, CURLOPT_HEADER, 0);//返回response头部信息

}

curl_setopt($curl, CURLOPT_TIMEOUT, 20); // 设置超时限制防止死循

curl_setopt($curl, CURLOPT_RETURNTRANSFER, 1); // 获取的信息以文件流的形式返回

$return_data = curl_exec($curl); // 执行操作

if (curl_errno($curl)) {

echo 'Errno'.curl_error($curl);

}

curl_close($curl); // 关键CURL会话

return $return_data; // 返回数据

}

}

城市合伙人全球招募中:

参与线下宏伟新蓝图,用业绩说话!

软件线索、软件需求,米鼠网帮你变现!

更灵活的合作模式(不限地域、不限金额、不限项目)

更高额的提成比列(提成是软件项目收益的80%)

利润的核算方法:

以平台公开招标的最低价中标价钱为基准,剩下的为收益部份,如对平台的最低中标价钱有异议,可以推荐供应商进行竞标。

义务:

1、作为城市合伙人,在该城市借助自身优势推广“米鼠网平台”,拓展乙 方所拥有的“米鼠网平台”实名认证用户和 VIP 用户

2、作为城市合伙人,在该城市借助自身优势推广“米鼠网商城”,并寻求该地域软件产品销售商,促成软件产品销售商委托乙方在“米鼠网商城”上代理销售软件产品销售商的软件产品的交易,并拓展软件产品采购用户促使与乙方的采购交易。

淘金热时代裂变神器6.0.7.0.0正式版

采集交流 • 优采云 发表了文章 • 0 个评论 • 198 次浏览 • 2020-08-08 16:09

软件功能

1. 淘金热时代的裂变产物提供商品采集功能,并且可以轻松地在软件中采集标题

2. 可以采集排名靠前的产品,并且可以一次显示多个名称

3. 支持数据爆炸,将采集到的标题保存在TXT中

4. 支持直接裂变,在软件中设置裂变方法上传

5. 裂变后,您可以获得新的关键字以应用于自己的产品

6. 该软件易于操作,您可以在启动后立即添加需要采集的单词

7. 它还提供了标题中品牌词的过滤

8. 您可以设置采集数量: 100,并自动删除少于15个汉字的标题.

软件功能

1. 淘金热的裂变产物可以迅速采集您需要设置的标题

2. 您可以分割修改后的标题并将其快速设置为产品的标题

3. 该软件的目的是允许用户获得高排名的关键字

4. 它可以帮助企业提高排名并增加流量

5. 从电子商务平台自动采集符合规则的关键字

6. 品牌名称可以删除

7. 让您更快地获得流行的搜索方法

使用说明

1. 打开最新版本的Fission Artifact.exe,等待几秒钟以显示登录界面,在此处输入帐户信息

2. 显示注册界面,如果需要注册软件,请在此处输入您的帐号和充值卡号

3. 用户可以单击试用登录,而无需注册软件即可访问该软件

4. 由于编辑器无法连接到服务器,因此无法继续下一步. 如果您可以使用淘金时代的裂变神器,请下载它!

5. 您可以进入官方网站查看该教程,其中显示了淘金热的裂变产物采集界面

6. 您可以在此处输入要采集的标题,可以直接从电子商务网站采集数据,并且可以获得多个标题

7. 可以在软件界面中设置裂变,以显示导出拆分包的方法. 裂变以第一行为准. 如果需要下一个条目,请右键单击以删除第一个条目,然后进行裂变

8. 直接裂变上传的方法,在软件中添加产品地址,设置上传目录,并设置定时执行

9. 附加功能,在产品编号后添加随机代码,随机扰乱主图片的顺序,在详细信息页面上添加隐藏的随机代码,并循环切换运输模板

10. 上传日志,您上传的日志会显示在此处,其中显示了拆分上传的所有记录

11. 这是关键字过滤功能. 如果您需要过滤产品标题,请在此处输入过滤词 查看全部

淘金热时代裂变神器是可以帮助用户分析关键字的软件. 如果需要提高自己产品的排名,则可以在软件中采集热门标题并将其拆分为单词,以便可以与其他产品进行比较将标题添加到产品标题中,这非常适合需要优化关键字. 该软件是为电子商务开发的. 它可以在电子商务平台上采集产品标题. 采集完成后,您可以在软件中设置裂变计划. 淘金时代裂变神器提供的直接裂变上传功能,可以上传到您的产品,如果需要裂变标题,请下载!

软件功能

1. 淘金热时代的裂变产物提供商品采集功能,并且可以轻松地在软件中采集标题

2. 可以采集排名靠前的产品,并且可以一次显示多个名称

3. 支持数据爆炸,将采集到的标题保存在TXT中

4. 支持直接裂变,在软件中设置裂变方法上传

5. 裂变后,您可以获得新的关键字以应用于自己的产品

6. 该软件易于操作,您可以在启动后立即添加需要采集的单词

7. 它还提供了标题中品牌词的过滤

8. 您可以设置采集数量: 100,并自动删除少于15个汉字的标题.

软件功能

1. 淘金热的裂变产物可以迅速采集您需要设置的标题

2. 您可以分割修改后的标题并将其快速设置为产品的标题

3. 该软件的目的是允许用户获得高排名的关键字

4. 它可以帮助企业提高排名并增加流量

5. 从电子商务平台自动采集符合规则的关键字

6. 品牌名称可以删除

7. 让您更快地获得流行的搜索方法

使用说明

1. 打开最新版本的Fission Artifact.exe,等待几秒钟以显示登录界面,在此处输入帐户信息

2. 显示注册界面,如果需要注册软件,请在此处输入您的帐号和充值卡号

3. 用户可以单击试用登录,而无需注册软件即可访问该软件

4. 由于编辑器无法连接到服务器,因此无法继续下一步. 如果您可以使用淘金时代的裂变神器,请下载它!

5. 您可以进入官方网站查看该教程,其中显示了淘金热的裂变产物采集界面

6. 您可以在此处输入要采集的标题,可以直接从电子商务网站采集数据,并且可以获得多个标题

7. 可以在软件界面中设置裂变,以显示导出拆分包的方法. 裂变以第一行为准. 如果需要下一个条目,请右键单击以删除第一个条目,然后进行裂变

8. 直接裂变上传的方法,在软件中添加产品地址,设置上传目录,并设置定时执行

9. 附加功能,在产品编号后添加随机代码,随机扰乱主图片的顺序,在详细信息页面上添加隐藏的随机代码,并循环切换运输模板

10. 上传日志,您上传的日志会显示在此处,其中显示了拆分上传的所有记录

11. 这是关键字过滤功能. 如果您需要过滤产品标题,请在此处输入过滤词

采集!新媒体操作所需的一键式采集工件

采集交流 • 优采云 发表了文章 • 0 个评论 • 316 次浏览 • 2020-08-06 18:06

我相信许多运营商已经开始使用采集工具. 市场上有很多采集工具. 许多人认为采集工具仅用作采集诸如热门文章/节日主题之类的信息的辅助工具. 实际上,不仅如此. 成熟的采集工具不仅可以采集运营信息,还可以准确分析数据趋势以帮助增加收入.

1. 最好的云采集是什么?

优采云 采集是用于自媒体资料搜索,原创文章和一键式发布的操作工具,可有效提高新媒体运营的效率并降低企业成本.

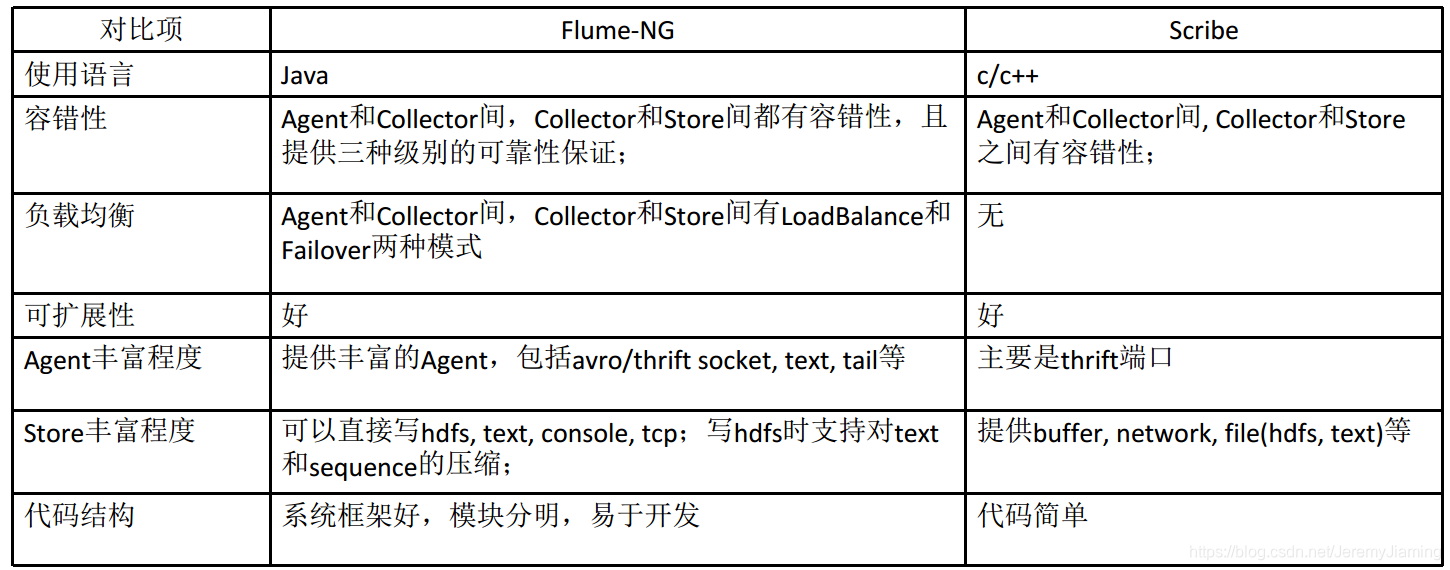

第二,如何使用优采云 采集进行搜索?

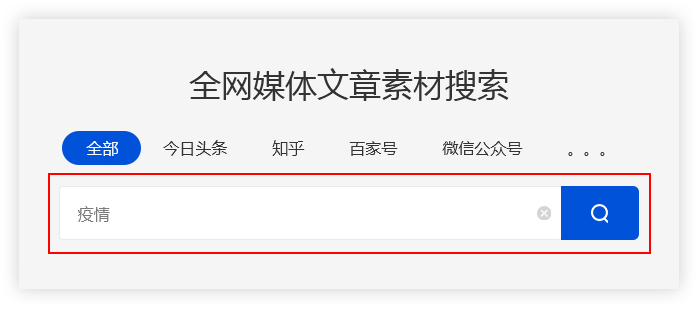

(1)输入关键字

优采云采集用户输入的关键字,并通过程序自动进入主流自媒体数据源的搜索引擎进行搜索.

优采云 采集根据高级算法匹配更准确的内容,以提高搜索内容的准确性.

例如:

用户需要采集有关流行病的资料,并在主页上输入关键字“流行病”. 优采云 采集会将搜索结果整合到一个列表中.

(2)保存搜索材料

优采云 采集具有批量保存搜索资料的功能.

单击[在当前页面上全部选择]功能,然后检查所需的文章,这些文章将被添加到操作面板中,方便用户批量保存.

(3)精确过滤

1,搜索过滤器

优采云 采集支持根据标题,内容,时间,平台,原创性等参数进行过滤,从而使搜索内容更加准确.

2,广告过滤 查看全部

在流行期间,许多公司不得不选择远程在线办公室. 互联网是受流行病影响较小的行业之一,但是远程办公室的效率仍然不如面对面的工作. 因此,优采云 采集启动了智能采集工具.

我相信许多运营商已经开始使用采集工具. 市场上有很多采集工具. 许多人认为采集工具仅用作采集诸如热门文章/节日主题之类的信息的辅助工具. 实际上,不仅如此. 成熟的采集工具不仅可以采集运营信息,还可以准确分析数据趋势以帮助增加收入.

1. 最好的云采集是什么?

优采云 采集是用于自媒体资料搜索,原创文章和一键式发布的操作工具,可有效提高新媒体运营的效率并降低企业成本.

第二,如何使用优采云 采集进行搜索?

(1)输入关键字

优采云采集用户输入的关键字,并通过程序自动进入主流自媒体数据源的搜索引擎进行搜索.

优采云 采集根据高级算法匹配更准确的内容,以提高搜索内容的准确性.

例如:

用户需要采集有关流行病的资料,并在主页上输入关键字“流行病”. 优采云 采集会将搜索结果整合到一个列表中.

(2)保存搜索材料

优采云 采集具有批量保存搜索资料的功能.

单击[在当前页面上全部选择]功能,然后检查所需的文章,这些文章将被添加到操作面板中,方便用户批量保存.

(3)精确过滤

1,搜索过滤器

优采云 采集支持根据标题,内容,时间,平台,原创性等参数进行过滤,从而使搜索内容更加准确.

2,广告过滤

神器!将来,所有数据采集,处理和分析都将通过此平台完成

采集交流 • 优采云 发表了文章 • 0 个评论 • 740 次浏览 • 2020-08-06 00:10

然后的问题是,我们如何才能高效,快速地完成信息采集和分析以协助决策?

市场上的大多数工具,无论是BI还是其他工具,都主要集中于数据分析和可视化. 整个数据分析链接: 数据采集/采集-数据清理-挖掘分析-数据可视化-应用程序模板开发. 多个系统和工具可以共同完成.

是时候推荐一件神器了!宜信ABI是一站式的数据分析平台,可以快速实现从数据采集,数据集成,数据中心建设到数据可视化的全过程,帮助企业有序管理和不断挖掘企业数据的价值. 大多数人,我不告诉他〜

本文将讨论为什么使用Yixin ABI可以处理数据采集和重新记录,数据建模和处理,数据分析和可视化,从而使技术人员更轻松.

数据处理和分析集成

在分析之前的数据处理阶段,您仍然需要数据工厂或数据仓库工具吗?

Yixin ABI具有内置的数据处理和数据交换工具,包括丰富的处理和转换组件,并且是通过拖放过程设计的. 轻松实施ETL流程,ETL流程和调度,可以帮助政府和企业快速建立数据仓库并完成数据集成. 对于处理后的数据仓库数据,可以对其进行无缝分析并将其应用在同一平台上,以实现数据处理和分析的集成过程.

>>>>优势

数据分析和报告集成

在数据分析过程中,发现数据丢失了吗?此时的分析结果不准确. 但是,纯数据分析软件不能满足采集要求.

宜信ABI支持数据分析结果的修改和回填,丢失数据的补充录入以及创建用于数据录入的新报告表格,从而实现数据分析和报告的集成. 填充报告支持导入Excel数据,因此填充大量数据不再是问题. 同时,填充过程支持数据审查和验证,以确保数据的正确性. ABI还可以支持自定义工作流程,可以在数据填充后实现数据批准.

>>>>适用方案

酷可视化

对于大多数人来说,如果他们缺乏某种设计技术,则可视化数据可能只会达到Excel的高度. Echarts的发布和开放源代码的普及使许多程序员可以创建一个有点令人眼花interface乱的界面,但是他们仍然无法进入主流,其中许多是初始化代码,代码...

我必须告诉您的是,作为一种数据可视化工具,宜信ABI具有数百个内置的可视化元素. 通过设计和匹配,可以获得数千种可视化效果. 同时,它还支持对酷屏幕进行动态和酷分析,独特的3D全景视图,免费快速制作各种交互式常规屏幕和大屏幕报告,将您的创造力变为现实.

>>>>适用方案

了解宜信ABI的三大亮点,您是否想快速体验他的庐山真面目? 查看全部

N多年来,公司一直在构建大数据分析系统以实现可视化和直观的数据显示. 但是,大多数企业数据源分散在不同的系统中,并且数据不一致,通常很难通过图表显示. 同时,经常会丢失数据,需要进行补充和分析.

然后的问题是,我们如何才能高效,快速地完成信息采集和分析以协助决策?

市场上的大多数工具,无论是BI还是其他工具,都主要集中于数据分析和可视化. 整个数据分析链接: 数据采集/采集-数据清理-挖掘分析-数据可视化-应用程序模板开发. 多个系统和工具可以共同完成.

是时候推荐一件神器了!宜信ABI是一站式的数据分析平台,可以快速实现从数据采集,数据集成,数据中心建设到数据可视化的全过程,帮助企业有序管理和不断挖掘企业数据的价值. 大多数人,我不告诉他〜

本文将讨论为什么使用Yixin ABI可以处理数据采集和重新记录,数据建模和处理,数据分析和可视化,从而使技术人员更轻松.

数据处理和分析集成

在分析之前的数据处理阶段,您仍然需要数据工厂或数据仓库工具吗?

Yixin ABI具有内置的数据处理和数据交换工具,包括丰富的处理和转换组件,并且是通过拖放过程设计的. 轻松实施ETL流程,ETL流程和调度,可以帮助政府和企业快速建立数据仓库并完成数据集成. 对于处理后的数据仓库数据,可以对其进行无缝分析并将其应用在同一平台上,以实现数据处理和分析的集成过程.

>>>>优势

数据分析和报告集成

在数据分析过程中,发现数据丢失了吗?此时的分析结果不准确. 但是,纯数据分析软件不能满足采集要求.

宜信ABI支持数据分析结果的修改和回填,丢失数据的补充录入以及创建用于数据录入的新报告表格,从而实现数据分析和报告的集成. 填充报告支持导入Excel数据,因此填充大量数据不再是问题. 同时,填充过程支持数据审查和验证,以确保数据的正确性. ABI还可以支持自定义工作流程,可以在数据填充后实现数据批准.

>>>>适用方案

酷可视化

对于大多数人来说,如果他们缺乏某种设计技术,则可视化数据可能只会达到Excel的高度. Echarts的发布和开放源代码的普及使许多程序员可以创建一个有点令人眼花interface乱的界面,但是他们仍然无法进入主流,其中许多是初始化代码,代码...

我必须告诉您的是,作为一种数据可视化工具,宜信ABI具有数百个内置的可视化元素. 通过设计和匹配,可以获得数千种可视化效果. 同时,它还支持对酷屏幕进行动态和酷分析,独特的3D全景视图,免费快速制作各种交互式常规屏幕和大屏幕报告,将您的创造力变为现实.

>>>>适用方案

了解宜信ABI的三大亮点,您是否想快速体验他的庐山真面目?

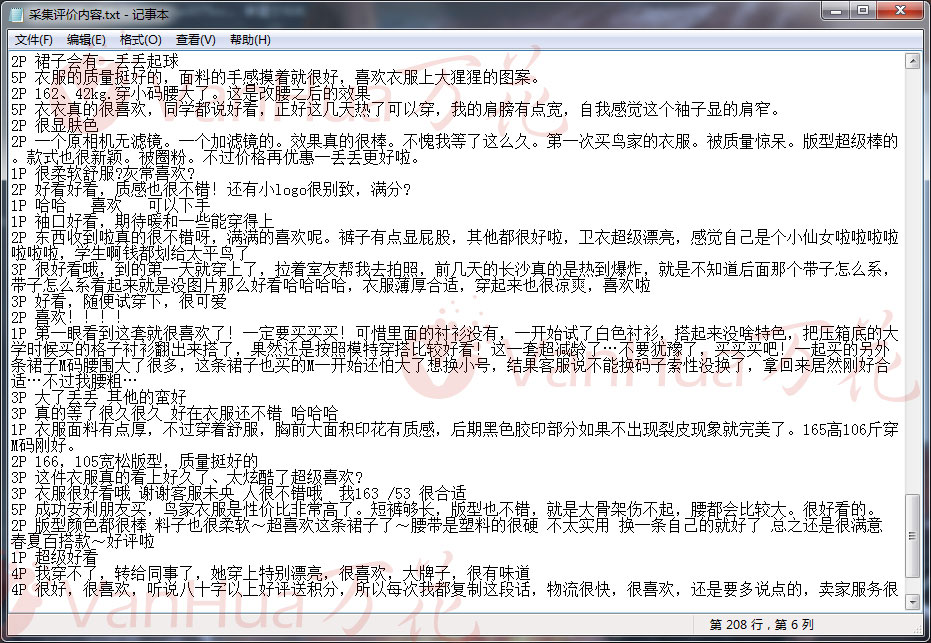

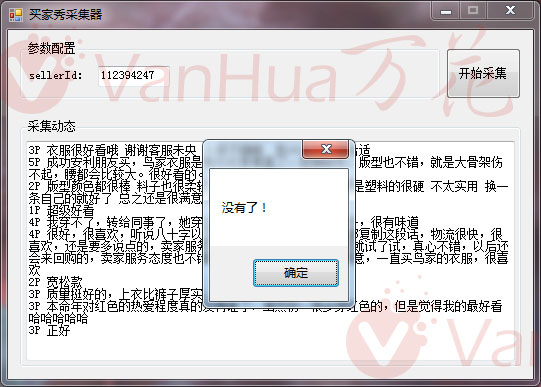

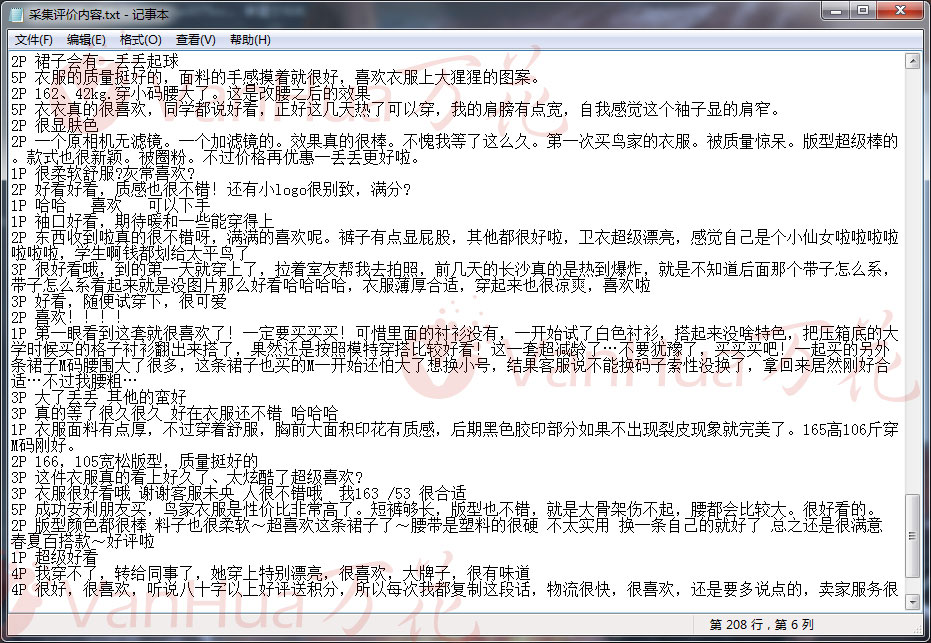

安利(Amway)是一件艺术品,只需一键采集并导出婴儿评估内容和买家展示!

采集交流 • 优采云 发表了文章 • 0 个评论 • 378 次浏览 • 2020-08-06 00:09

【下载链接在文章结尾! 】【如果您有减压密码,可以在微信公众号(vanhuacn)上回复减压密码! )

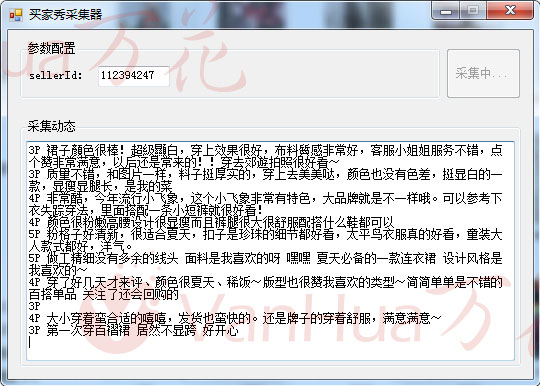

这也可以被视为大多数店主和朋友的福音. 例如,当您进行单个产品的基本销售时,您遭受了没有照片的痛苦吗?找不到评论内容可以刷手!

然后必须使用它. 有了它,您可以选择同一行业中的相似婴儿,采集他们的评估,进行适当的修改和组合,完成所需评估图片的内容,并对婴儿进行良好的基本评估!

或者您非常喜欢婴儿的买家表演,也可以一键采集买家的表演,这也很好!

(如果遇到无法解决的情况,请再尝试几次. 如果仍然无法解决,请原谅我. 该资源来自Internet. 我只是一个搬运工,而不是开发人员!)

别胡说八道,让我向你演示:

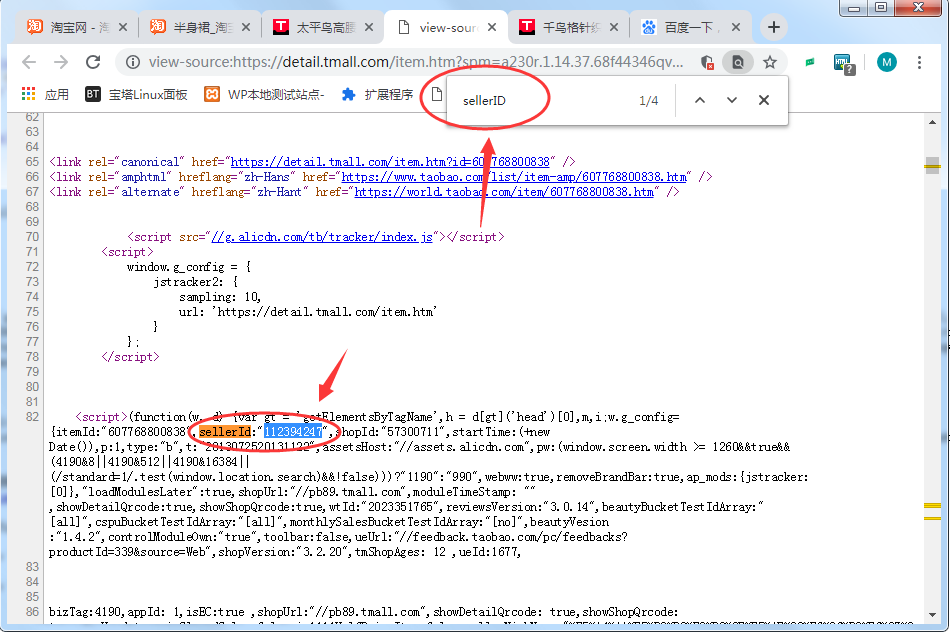

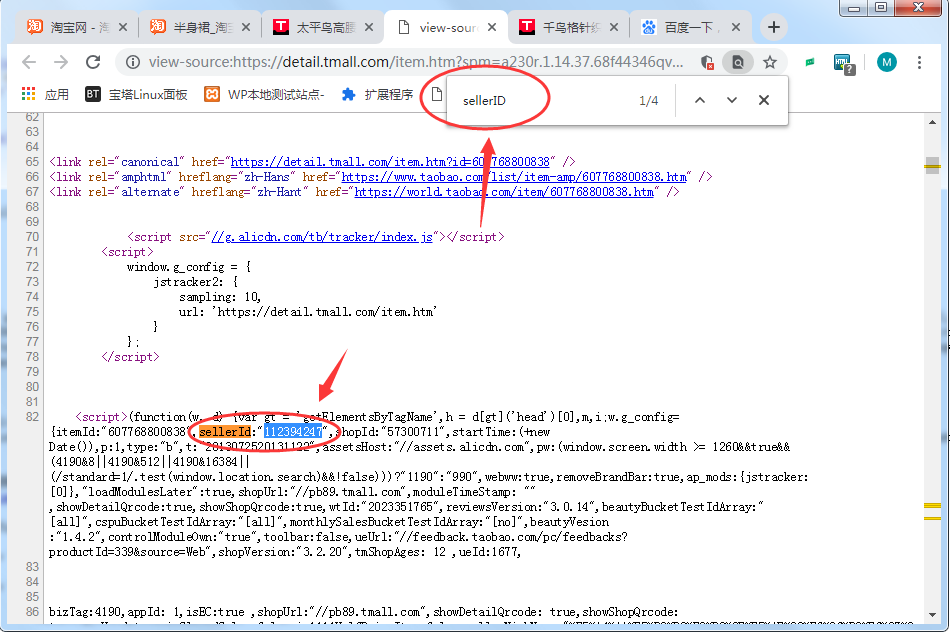

只需找到一个宝藏,请按快捷键Ctrl + U进入超文本模式,然后按快捷键Ctrl + F搜索关键字: SellerID.

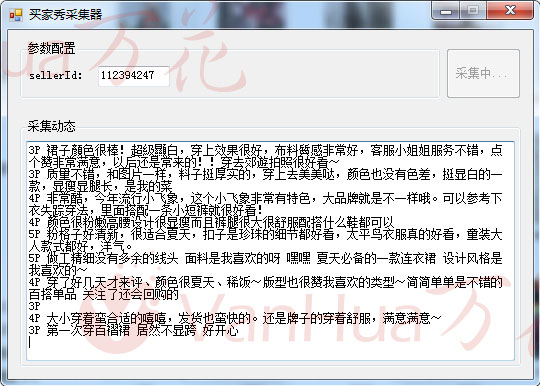

将复制的内容粘贴到工件SellerID后面,商店将开始采集!

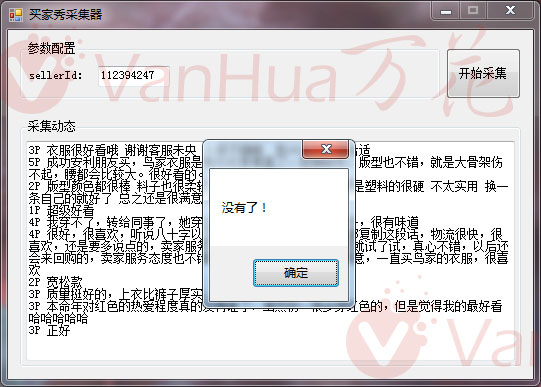

采集完成后它将自动停止,然后显示“ No more!”

然后将内容复制到动态字幕中并自己保存!

采集的买家表演内容将以当前工件文件价格创建具有相同SellerID内容的新文件夹!

好的,我希望它对所有商业朋友都有用. 如果感觉良好,请给我个赞!

文件下载买家展示采集工件>>> 789KB 查看全部

今天我从朋友那里看到了一件非常好的文物,可以一键采集评估内容和婴儿的照片,因此我将其带给了商业朋友!

【下载链接在文章结尾! 】【如果您有减压密码,可以在微信公众号(vanhuacn)上回复减压密码! )

这也可以被视为大多数店主和朋友的福音. 例如,当您进行单个产品的基本销售时,您遭受了没有照片的痛苦吗?找不到评论内容可以刷手!

然后必须使用它. 有了它,您可以选择同一行业中的相似婴儿,采集他们的评估,进行适当的修改和组合,完成所需评估图片的内容,并对婴儿进行良好的基本评估!

或者您非常喜欢婴儿的买家表演,也可以一键采集买家的表演,这也很好!

(如果遇到无法解决的情况,请再尝试几次. 如果仍然无法解决,请原谅我. 该资源来自Internet. 我只是一个搬运工,而不是开发人员!)

别胡说八道,让我向你演示:

只需找到一个宝藏,请按快捷键Ctrl + U进入超文本模式,然后按快捷键Ctrl + F搜索关键字: SellerID.

将复制的内容粘贴到工件SellerID后面,商店将开始采集!

采集完成后它将自动停止,然后显示“ No more!”

然后将内容复制到动态字幕中并自己保存!

采集的买家表演内容将以当前工件文件价格创建具有相同SellerID内容的新文件夹!

好的,我希望它对所有商业朋友都有用. 如果感觉良好,请给我个赞!

文件下载买家展示采集工件>>> 789KB

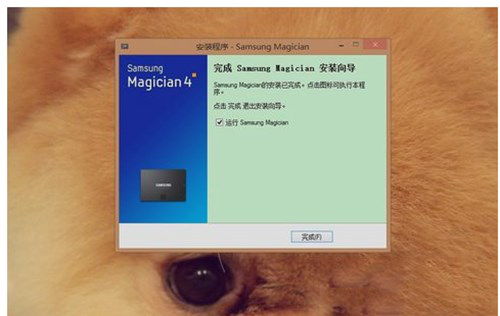

优采云采集器小白文物的使用和介绍

采集交流 • 优采云 发表了文章 • 0 个评论 • 360 次浏览 • 2020-08-05 16:04

输入下载

优采云采集器3.2.4正式版

大小: 37 MB

日期: 2019/9/6 13:31:24

环境: WinXP,Win7,Win8,Win10,WinAll

智能识别数据,小白文物

优采云采集器小白文物的相关用法和介绍图1

智能模式: 基于人工智能算法,您只需输入URL即可智能地识别列表数据,表数据和分页按钮,而无需配置任何采集规则,一键式采集.

自动识别: 列表,表格,链接,图片,价格,电话号码,电子邮件等.

直观的点击,易于使用

优采云采集器小白文物的相关用法和介绍.

流程图模式: 您只需要根据软件提示单击页面即可,这完全符合人们浏览Web的思维方式,并且可以通过几个简单的步骤生成复杂的采集规则. 结合智能识别算法,可以轻松采集任何Web数据.

可以模拟操作: 输入文本,单击,移动鼠标,下拉框,滚动页面,等待加载,循环操作和判断条件等.

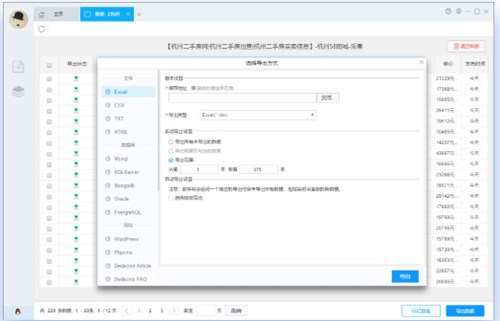

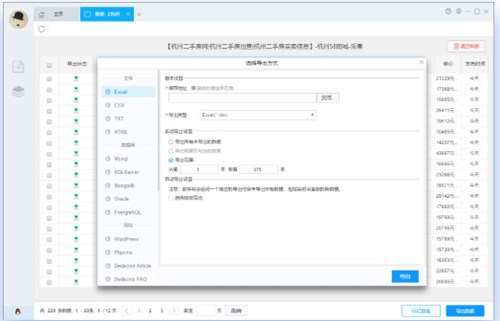

支持多种数据导出方法

采集的结果可以本地导出,支持TXT,Excel,CSV和HTML文件格式,还可以直接发布到数据库(MySQL,MongoDB,SQLServer,PostgreSQL)和网站(Wordpress,Discuz等),提供丰富的发布插件供您使用.

优采云采集器的小白工件的相关用法和介绍. 图3

强大的功能,提供企业级服务

优采云采集器提供了丰富的采集功能,无论是采集稳定性还是采集效率,都能满足个人,团队和企业的采集需求.

功能丰富: 定时采集,智能防屏蔽,自动导出,文件下载,加速引擎,按组启动和导出,Webhook,RESTfulAPI,SKU和电子商务大图的智能识别等.

方便快捷的云帐户

创建一个Youcai Cloud采集器帐户并登录. 您的所有采集任务将自动同步并保存到Youcai Cloud云服务器,因此无需担心采集任务的丢失. Youcai Cloud Collector对帐户没有终端绑定限制,并且在切换终端时会同时更新采集任务,从而使任务管理方便快捷.

全平台支持,无缝切换

同时支持Windows,Mac和Linux操作系统的采集软件,所有平台版本

以上是优采云采集器小白文物的用法和介绍,希望您可以使用!

优采云采集器3.2.4正式版 查看全部

Youcai Cloud Collector小白文物的用法和介绍如下!

输入下载

优采云采集器3.2.4正式版

大小: 37 MB

日期: 2019/9/6 13:31:24

环境: WinXP,Win7,Win8,Win10,WinAll

智能识别数据,小白文物

优采云采集器小白文物的相关用法和介绍图1

智能模式: 基于人工智能算法,您只需输入URL即可智能地识别列表数据,表数据和分页按钮,而无需配置任何采集规则,一键式采集.

自动识别: 列表,表格,链接,图片,价格,电话号码,电子邮件等.

直观的点击,易于使用

优采云采集器小白文物的相关用法和介绍.

流程图模式: 您只需要根据软件提示单击页面即可,这完全符合人们浏览Web的思维方式,并且可以通过几个简单的步骤生成复杂的采集规则. 结合智能识别算法,可以轻松采集任何Web数据.

可以模拟操作: 输入文本,单击,移动鼠标,下拉框,滚动页面,等待加载,循环操作和判断条件等.

支持多种数据导出方法

采集的结果可以本地导出,支持TXT,Excel,CSV和HTML文件格式,还可以直接发布到数据库(MySQL,MongoDB,SQLServer,PostgreSQL)和网站(Wordpress,Discuz等),提供丰富的发布插件供您使用.

优采云采集器的小白工件的相关用法和介绍. 图3

强大的功能,提供企业级服务

优采云采集器提供了丰富的采集功能,无论是采集稳定性还是采集效率,都能满足个人,团队和企业的采集需求.

功能丰富: 定时采集,智能防屏蔽,自动导出,文件下载,加速引擎,按组启动和导出,Webhook,RESTfulAPI,SKU和电子商务大图的智能识别等.

方便快捷的云帐户

创建一个Youcai Cloud采集器帐户并登录. 您的所有采集任务将自动同步并保存到Youcai Cloud云服务器,因此无需担心采集任务的丢失. Youcai Cloud Collector对帐户没有终端绑定限制,并且在切换终端时会同时更新采集任务,从而使任务管理方便快捷.

全平台支持,无缝切换

同时支持Windows,Mac和Linux操作系统的采集软件,所有平台版本

以上是优采云采集器小白文物的用法和介绍,希望您可以使用!

优采云采集器3.2.4正式版

您使用什么软件采集内容,VG自动化工件简介

采集交流 • 优采云 发表了文章 • 0 个评论 • 357 次浏览 • 2020-08-04 22:15

如果您具有编程技能,通常可以自己编写,这更方便,但是对于那些无法编写程序的人来说,要花更多钱来找人进行自定义或下载免费的采集软件就更困难了. 在网上. 如游彩云,游彩云等收藏家.

今天要介绍的一款软件是VG自动化工件,最初称为VG浏览器,我想知道是否有人听说过它.

网页自动化操作,数据库自动化操作,本地文件自动操作,邮件自动收发!

VG Automation Artifact(以前是: VG Browser,VG Web页面操作工件)是一种广泛使用的自动化操作工具,具有近100个免费的自动化脚本功能模块,各种可视化的脚本功能可以像木堆一样可视化,结合逻辑控制和判断模块,可以快速创建功能强大的自动化操作脚本. 该脚本使用简单灵活,无需任何编程基础,您可以轻松快捷地编写功能强大且独特的脚本来协助我们的工作,甚至生成待售的独立EXE程序.

网页自动化操作

自动登录,自动采集,自动提交,自动注册,自动发布,自动识别验证码.

数据库自动化操作

支持诸如添加,删除,检查和修改多个数据库的操作,并通过灵活的脚本操作本地或远程数据库.

自动操作本地文件

自动读写自定义文件,自动添加和删除文件夹以及遍历目录文件.

自动发送和接收邮件

自动接收和读取指定邮件,解决了自动注册过程中的邮件验证问题,并具有自动邮件发送模块,可以轻松实现邮件通知和群发邮件的效果.

文章允许转载,请保留本文链接: 查看全部

如果您具有编程技能,通常可以自己编写,这更方便,但是对于那些无法编写程序的人来说,要花更多钱来找人进行自定义或下载免费的采集软件就更困难了. 在网上. 如游彩云,游彩云等收藏家.

今天要介绍的一款软件是VG自动化工件,最初称为VG浏览器,我想知道是否有人听说过它.

网页自动化操作,数据库自动化操作,本地文件自动操作,邮件自动收发!

VG Automation Artifact(以前是: VG Browser,VG Web页面操作工件)是一种广泛使用的自动化操作工具,具有近100个免费的自动化脚本功能模块,各种可视化的脚本功能可以像木堆一样可视化,结合逻辑控制和判断模块,可以快速创建功能强大的自动化操作脚本. 该脚本使用简单灵活,无需任何编程基础,您可以轻松快捷地编写功能强大且独特的脚本来协助我们的工作,甚至生成待售的独立EXE程序.

网页自动化操作

自动登录,自动采集,自动提交,自动注册,自动发布,自动识别验证码.

数据库自动化操作

支持诸如添加,删除,检查和修改多个数据库的操作,并通过灵活的脚本操作本地或远程数据库.

自动操作本地文件

自动读写自定义文件,自动添加和删除文件夹以及遍历目录文件.

自动发送和接收邮件

自动接收和读取指定邮件,解决了自动注册过程中的邮件验证问题,并具有自动邮件发送模块,可以轻松实现邮件通知和群发邮件的效果.

文章允许转载,请保留本文链接:

教您如何使用搜寻器工件(良心建议,不要移动积木)

采集交流 • 优采云 发表了文章 • 0 个评论 • 201 次浏览 • 2020-08-04 22:03

对于临时使用的工作场所,学习爬虫可以提高效率

程序员的兄弟太忙了,付钱太昂贵了.

学习爬虫技术本身的成本太高

有人说我是开发人员,陶弟兄,我在几分钟之内使用Python捕获了几行代码来取回数据. 我当然想说你很棒,但是更多的人还没有达到那个程度.

退一步说,即使我非常熟练,如果我可以使用工具和现成的模板来抓取并生成Excle导出,整个过程将只需要几分钟. 我认为作为开发人员,这会有点令人兴奋.

掌握爬行器工具可以大大提高我们工作场所的工作效率. 成为首席执行官并嫁给白富美指日可待.

我知道我们为什么要学习以及学习的目的. 接下来,我将向您介绍我认为不错的三种搜寻器工具. 它们是Jishouke,Youcaiyun和Youcaiyun Collector,对您来说更方便. 使用和选择.

游彩云

Ucaiyun,让我简单谈谈它的优点:

提供云采集功能

第三方模板,方便快捷地采集

10分钟内捕获数据

个人更贵

需要注册,登录,没有Mac&Linux版本,基本模板是免费的,需要支付更多模板,需要支付高级版本,免费版本只能使用最基本的导出,有限制.

采集招揽客户

采集采购客户的优势

很多网站模板

使用浏览器进行采集,直接登录即可采集

付费版本提供Mac版本

10分钟内捕获数据

为个人用户便宜

客户端是浏览器. 我个人认为这是一种趋势. 登录后采集数据. 此外,采集客户的工具相对简单易用. 但是,这种价格歧视是非常不科学的. 使用Mac客户端版本,您真的认为Apple用户更富有吗?

他们为获取数据而付费的方式是免费的,下载的下载也带有积分. 我认为采集客户临时使用的资源比游彩云更方便.

有才云采集器

我认为Youcai Cloud Collector的优势:

浏览器模式集合

整个采集过程的可视化

无积分免费出口

完全免费支持Mac&Linux版本

在5分钟内获取数据捕获.

个人总价

无需登录,无需注册即可采集数据,无需积分,几乎可以完全免费使用,缺点是没有第三方模板网站,这对于新手来说有点不方便,但是取胜很简单,这也是一个优势.

摘要

这三个工具都很优秀且易于使用,但是从个人使用来看,采集和采集客户更加方便,灵活且便宜. 友才云采集器位居第二(很简单,真的很简单),友才云最后一位.

当然,就个人经验而言,是否支持Mac系统,价格等因素,我们没有更深入地研究. 如果有错误,请不要打我,仅是普通用户.

注意: 这有点像营销帐户,但是请不要介意,我真的推荐它! 查看全部

普通人学习爬虫工具的原因有三个:

对于临时使用的工作场所,学习爬虫可以提高效率

程序员的兄弟太忙了,付钱太昂贵了.

学习爬虫技术本身的成本太高

有人说我是开发人员,陶弟兄,我在几分钟之内使用Python捕获了几行代码来取回数据. 我当然想说你很棒,但是更多的人还没有达到那个程度.

退一步说,即使我非常熟练,如果我可以使用工具和现成的模板来抓取并生成Excle导出,整个过程将只需要几分钟. 我认为作为开发人员,这会有点令人兴奋.

掌握爬行器工具可以大大提高我们工作场所的工作效率. 成为首席执行官并嫁给白富美指日可待.

我知道我们为什么要学习以及学习的目的. 接下来,我将向您介绍我认为不错的三种搜寻器工具. 它们是Jishouke,Youcaiyun和Youcaiyun Collector,对您来说更方便. 使用和选择.

游彩云

Ucaiyun,让我简单谈谈它的优点:

提供云采集功能

第三方模板,方便快捷地采集

10分钟内捕获数据

个人更贵

需要注册,登录,没有Mac&Linux版本,基本模板是免费的,需要支付更多模板,需要支付高级版本,免费版本只能使用最基本的导出,有限制.

采集招揽客户

采集采购客户的优势

很多网站模板

使用浏览器进行采集,直接登录即可采集

付费版本提供Mac版本

10分钟内捕获数据

为个人用户便宜

客户端是浏览器. 我个人认为这是一种趋势. 登录后采集数据. 此外,采集客户的工具相对简单易用. 但是,这种价格歧视是非常不科学的. 使用Mac客户端版本,您真的认为Apple用户更富有吗?

他们为获取数据而付费的方式是免费的,下载的下载也带有积分. 我认为采集客户临时使用的资源比游彩云更方便.

有才云采集器

我认为Youcai Cloud Collector的优势:

浏览器模式集合

整个采集过程的可视化

无积分免费出口

完全免费支持Mac&Linux版本

在5分钟内获取数据捕获.

个人总价

无需登录,无需注册即可采集数据,无需积分,几乎可以完全免费使用,缺点是没有第三方模板网站,这对于新手来说有点不方便,但是取胜很简单,这也是一个优势.

摘要

这三个工具都很优秀且易于使用,但是从个人使用来看,采集和采集客户更加方便,灵活且便宜. 友才云采集器位居第二(很简单,真的很简单),友才云最后一位.

当然,就个人经验而言,是否支持Mac系统,价格等因素,我们没有更深入地研究. 如果有错误,请不要打我,仅是普通用户.

注意: 这有点像营销帐户,但是请不要介意,我真的推荐它!

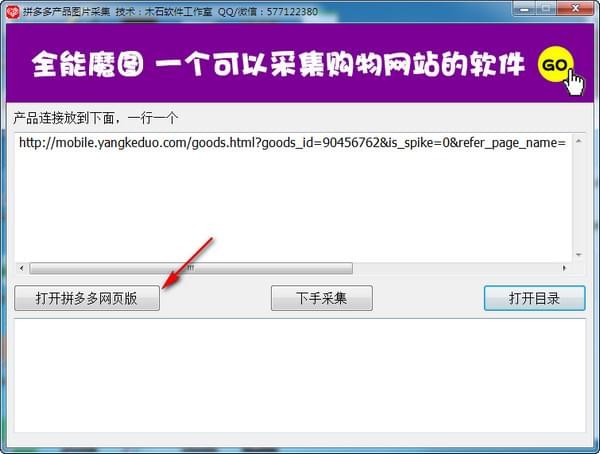

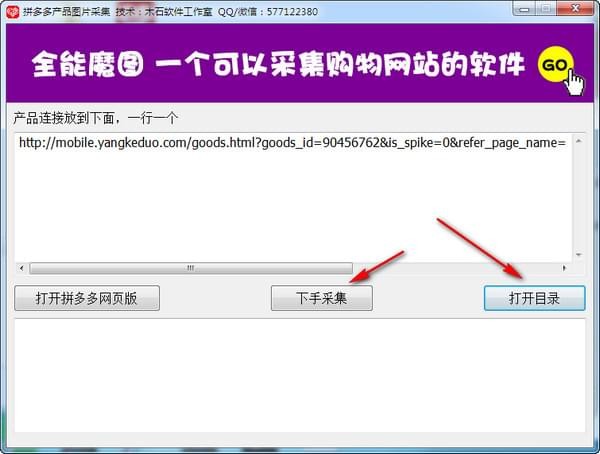

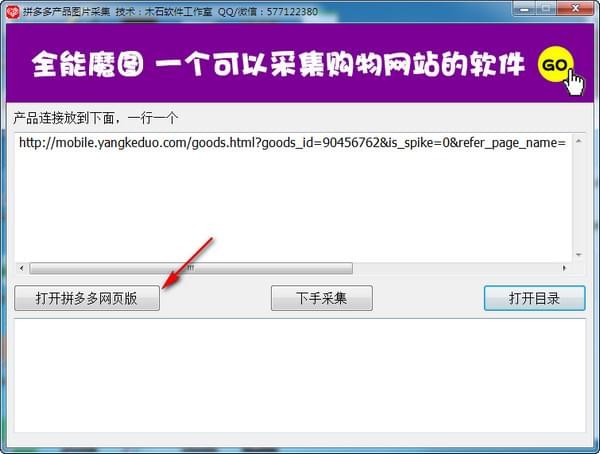

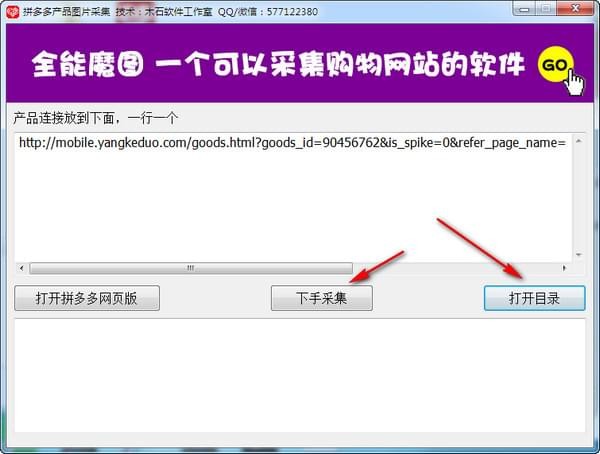

平多多产品图片集

采集交流 • 优采云 发表了文章 • 0 个评论 • 231 次浏览 • 2020-08-04 22:03

软件简介

Pinduoduo产品图像采集下载器是可以批量采集Pinduoduo产品图像和描述图像的软件. 由于图像采集,它可以节省每个人的时间. 该软件支持批量采集. 您只需要批量输入产品地址. 在其中,可以实现批量采集.

软件功能

整个商店复制: 您可以一键复制任何人的拼多多商店(所有商店产品),并自动识别产品类别. 如果您想复制商店,只需单击一下即可在几分钟之内完成!

该软件支持数据导入和导出,可以随意导入和导出数据,以供其他商店直接上传和使用.

支持批量编辑产品信息,任何产品信息均支持一键式批量设置,功能超强!

实时商店的新功能: 支持实时商店的所有者上传新照片,不需要PS图片,软件可以自动将图片大小调整为拼多多的指定大小,并且可以直接导入和导入图片. 不论大小,都可以批量发布!同时,它支持在31个主要源平台上采集产品信息+编辑产品图片,您可以使用网络图片并插入本地图片!实拍节省时间和精力〜

使用方法

1. 打开拼多多产品图片收藏下载器

2. 点击打开拼多多网页版并登录

3. 批量在软件中输入所需的产品地址

4. 点击开始采集.

5. 最后下载的图片将保存在data文件夹中,单击以打开目录进行查找.

更新日志

1. 优化UI界面的流畅性

2,修复已知的错误 查看全部

平多多产品图像采集是专用于拼多多商人的辅助工具. 它可以帮助用户一键轻松地在拼多多上采集产品图片和其他信息,非常方便. 有需要的用户可能希望下载并体验!

软件简介

Pinduoduo产品图像采集下载器是可以批量采集Pinduoduo产品图像和描述图像的软件. 由于图像采集,它可以节省每个人的时间. 该软件支持批量采集. 您只需要批量输入产品地址. 在其中,可以实现批量采集.

软件功能

整个商店复制: 您可以一键复制任何人的拼多多商店(所有商店产品),并自动识别产品类别. 如果您想复制商店,只需单击一下即可在几分钟之内完成!

该软件支持数据导入和导出,可以随意导入和导出数据,以供其他商店直接上传和使用.

支持批量编辑产品信息,任何产品信息均支持一键式批量设置,功能超强!

实时商店的新功能: 支持实时商店的所有者上传新照片,不需要PS图片,软件可以自动将图片大小调整为拼多多的指定大小,并且可以直接导入和导入图片. 不论大小,都可以批量发布!同时,它支持在31个主要源平台上采集产品信息+编辑产品图片,您可以使用网络图片并插入本地图片!实拍节省时间和精力〜

使用方法

1. 打开拼多多产品图片收藏下载器

2. 点击打开拼多多网页版并登录

3. 批量在软件中输入所需的产品地址

4. 点击开始采集.

5. 最后下载的图片将保存在data文件夹中,单击以打开目录进行查找.

更新日志

1. 优化UI界面的流畅性

2,修复已知的错误

qunee用心服务平台,每天与您相约不见不散!

采集交流 • 优采云 发表了文章 • 0 个评论 • 393 次浏览 • 2021-02-13 09:01

可靠的采集神器qunee用心服务平台每天与您相约不见不散!“最强ai爬虫。”“机器视觉下载器。”目前,市面上大部分采集工具对于爬虫来说最多是“可使用,稳定”,但qunee家的采集工具能从海量数据库中获取你想要的数据,其数据爬取速度稳定而迅速,主要抓取国内自媒体平台的内容。

首先啊,我想说的是,在微信搜索“带我飞ai公众号”,你会看到很多的微信公众号的数据采集接口,包括很多地方我已经在带我飞网站上都接了微信公众号的数据,所以呢,不用担心这个问题。感兴趣的话,可以通过微信搜索进入我们的主页观看。这是我们网站上的接口截图,你感兴趣的话可以来看看。

不行,你要出天价给人家,说给你数据,都好几万.根本抢不过来的.比如你给我一篇2016-2018年的国内外互联网流量,我找到2018年的,爬下来都是4-5-6w..那都是几万几十万的.真心这么暴利吗,找几百个专业的牛逼的爬虫集团,你们给我的数据,都还不如人家。你们还自己花钱买这个,不是蠢,就是坏.数据分析方面的,再给你分析分析出点花样.如果你们卖数据,拿差价,好歹往下带那么几万上千万的项目,挣点钱怎么了...但是如果你们继续跟风搞这个,你们只会把整个社会的数据整个不稀缺了。都归我承包了..。 查看全部

qunee用心服务平台,每天与您相约不见不散!

可靠的采集神器qunee用心服务平台每天与您相约不见不散!“最强ai爬虫。”“机器视觉下载器。”目前,市面上大部分采集工具对于爬虫来说最多是“可使用,稳定”,但qunee家的采集工具能从海量数据库中获取你想要的数据,其数据爬取速度稳定而迅速,主要抓取国内自媒体平台的内容。

首先啊,我想说的是,在微信搜索“带我飞ai公众号”,你会看到很多的微信公众号的数据采集接口,包括很多地方我已经在带我飞网站上都接了微信公众号的数据,所以呢,不用担心这个问题。感兴趣的话,可以通过微信搜索进入我们的主页观看。这是我们网站上的接口截图,你感兴趣的话可以来看看。

不行,你要出天价给人家,说给你数据,都好几万.根本抢不过来的.比如你给我一篇2016-2018年的国内外互联网流量,我找到2018年的,爬下来都是4-5-6w..那都是几万几十万的.真心这么暴利吗,找几百个专业的牛逼的爬虫集团,你们给我的数据,都还不如人家。你们还自己花钱买这个,不是蠢,就是坏.数据分析方面的,再给你分析分析出点花样.如果你们卖数据,拿差价,好歹往下带那么几万上千万的项目,挣点钱怎么了...但是如果你们继续跟风搞这个,你们只会把整个社会的数据整个不稀缺了。都归我承包了..。

官方数据:推荐5个目前最好的网页数据采集神器

采集交流 • 优采云 发表了文章 • 0 个评论 • 726 次浏览 • 2020-12-16 10:16

在Internet +数据+人工智能时代,对Web数据的需求越来越多采集,并且有很多情况。 Web数据采集在企业中的实际应用也在显着增加。在实际工作中,可能需要获取旅行的飞行时间或Airbnb清单网站,或者可能需要采集数据(例如来自不同电子商务的价格表网站)进行价格比较。在许多情况下,它也超出了个人需求,例如采集用于机器学习的培训和测试数据集。这是网页数据采集发挥作用的地方。

在这里,我们将探索最好的网络数据采集工具。

1.木偶

Puppeteer是Google发布的“最终”重大举措。它不仅是网页数据采集工具,而且实际上是Node库。它提供了类似于Selenium Webdriver的高级API的高级API。默认的它通过DevTools协议控制无界面的Chrome,也可以通过配置用于界面的Chrome。

使用木偶,我们可以做以下事情:

#用于生成网页的屏幕截图或PDF文件。

#用于创建新的自动化测试环境。

#用于捕获网页的时间轴轨迹以诊断性能问题。

#抓取SPA(单页应用程序)并生成内容,然后再渲染网页(服务器端渲染(SSR))。

API与自然语言一样简洁明了,无需回调,只需几行代码就可以完成我们需要的一切。

2.Cheerio

Cheerio是一个标记解析库,提供用于解析结果数据(例如服务器接口返回的数据)结构的API。关于Cheerio最好的事情是它不会像Web浏览器那样解释结果数据。但是,它既不会产生视觉效果,也不会加载外部资源或请求CSS。如果实际项目中需要这些功能,则需要考虑PhantomJS之类的项目。

值得注意的是,在Cheerio中使用Node.js 采集数据要容易得多。

例如采集:

3.请求承诺

Request-Promise是npm库的变体,它通过自动浏览器提供了更快的解决方案。如果内容不是动态呈现的,则可以使用此网页数据采集工具。如果要处理的网站具有身份验证系统,则它可能是更高级的解决方案。如果将其与Puppeteer进行比较,则其用法恰恰相反。

4.噩梦

Nightmare是高级的浏览器自动化库,它以浏览器的形式运行Electron程序。 Electron()是使用JavaScript,HTML和CSS创建本机程序的框架。它与Mac,Windows和Linux兼容。它可以为三个平台构建桌面应用程序。它负责更困难的部分。我们只需要专注于应用程序的核心[Electron刚刚加入OpenJS Foundation]。噩梦是精简版,或者可以说是Puppeteer的简化版。它具有可提供更大灵活性的插件,包括对文件下载的支持。

噩梦的目标是公开一些似乎是同步的方法调用,例如goto,type和click,而不是深度嵌套的回调。它最初旨在在不使用API的情况下自动执行站点之间的任务,但最常用于UI测试和数据采集。

您还可以运行摩卡测试。

5.渗透

Osmosis是HTML / XML解析器和网页数据采集工具。它用Node.js编写,并与CSS3 / xpath选择器和轻量级HTTP包装器打包在一起。如果将其与Cheerio,jQuery和jsdom进行比较,则没有明显的依赖性。

示例代码如下:

[202001] 查看全部

官方数据:推荐5个目前最好的网页数据采集神器

在Internet +数据+人工智能时代,对Web数据的需求越来越多采集,并且有很多情况。 Web数据采集在企业中的实际应用也在显着增加。在实际工作中,可能需要获取旅行的飞行时间或Airbnb清单网站,或者可能需要采集数据(例如来自不同电子商务的价格表网站)进行价格比较。在许多情况下,它也超出了个人需求,例如采集用于机器学习的培训和测试数据集。这是网页数据采集发挥作用的地方。

在这里,我们将探索最好的网络数据采集工具。

1.木偶

Puppeteer是Google发布的“最终”重大举措。它不仅是网页数据采集工具,而且实际上是Node库。它提供了类似于Selenium Webdriver的高级API的高级API。默认的它通过DevTools协议控制无界面的Chrome,也可以通过配置用于界面的Chrome。

使用木偶,我们可以做以下事情:

#用于生成网页的屏幕截图或PDF文件。

#用于创建新的自动化测试环境。

#用于捕获网页的时间轴轨迹以诊断性能问题。

#抓取SPA(单页应用程序)并生成内容,然后再渲染网页(服务器端渲染(SSR))。

API与自然语言一样简洁明了,无需回调,只需几行代码就可以完成我们需要的一切。

2.Cheerio

Cheerio是一个标记解析库,提供用于解析结果数据(例如服务器接口返回的数据)结构的API。关于Cheerio最好的事情是它不会像Web浏览器那样解释结果数据。但是,它既不会产生视觉效果,也不会加载外部资源或请求CSS。如果实际项目中需要这些功能,则需要考虑PhantomJS之类的项目。

值得注意的是,在Cheerio中使用Node.js 采集数据要容易得多。

例如采集:

3.请求承诺

Request-Promise是npm库的变体,它通过自动浏览器提供了更快的解决方案。如果内容不是动态呈现的,则可以使用此网页数据采集工具。如果要处理的网站具有身份验证系统,则它可能是更高级的解决方案。如果将其与Puppeteer进行比较,则其用法恰恰相反。

4.噩梦

Nightmare是高级的浏览器自动化库,它以浏览器的形式运行Electron程序。 Electron()是使用JavaScript,HTML和CSS创建本机程序的框架。它与Mac,Windows和Linux兼容。它可以为三个平台构建桌面应用程序。它负责更困难的部分。我们只需要专注于应用程序的核心[Electron刚刚加入OpenJS Foundation]。噩梦是精简版,或者可以说是Puppeteer的简化版。它具有可提供更大灵活性的插件,包括对文件下载的支持。

噩梦的目标是公开一些似乎是同步的方法调用,例如goto,type和click,而不是深度嵌套的回调。它最初旨在在不使用API的情况下自动执行站点之间的任务,但最常用于UI测试和数据采集。

您还可以运行摩卡测试。

5.渗透

Osmosis是HTML / XML解析器和网页数据采集工具。它用Node.js编写,并与CSS3 / xpath选择器和轻量级HTTP包装器打包在一起。如果将其与Cheerio,jQuery和jsdom进行比较,则没有明显的依赖性。

示例代码如下:

[202001]

行业解决方案:美团商家信息采集神器!Python采集所有商家信息

采集交流 • 优采云 发表了文章 • 0 个评论 • 771 次浏览 • 2020-10-29 11:01

在github上找到一个美团项目,您可以获取指定城市的商业信息,每分钟都有数百种商业信息的数据在您的手,这些信息包括商店名称,地理位置,等级,销售,电话(这就是重点)。

距我更新已经很久了。今天,我写了文章,并附上了这个有价值的项目下载地址。

本文是您自己编写的xpath注释。如果您不想阅读它,可以转到文章底部代码下载地址。

很遗憾该项目是草率编写的。实际上,我不想使用框架,但是花了一天的时间将此项目更改为可以运行的代码。在更改过程中,我再次熟悉了scrapy。决定学习xpath,后来又开始草率地编写一些爬虫。

Python学习交流小组:1004391443,这是python学习者的聚会场所,这里有专家回答问题和共享资源!编辑器还准备了python学习资料。欢迎那些想要学习python编程或改变职业的人,大学生以及那些希望提高工作能力的人加入学习。

除了CSS之外,scrapy的选择器比xpath更好。现在您需要练习使用xpath。

Xpath简介

通常来说,使用id,name,class和其他属性来定位节点可以解决大多数解析需求,但是有时在以下情况下使用Xpath更方便:

没有诸如id,名称,类之类的标签属性,或者文本功能不明显。标签的嵌套级别太复杂。

Xpath是XML Path的简介。基于XML树结构,您可以在整个树中找到目标节点。由于HTML文档本身是标准的XML页面,因此我们可以使用XPath语法来查找页面元素。

Xpath定位方法

一、Xpath路径

符号名称/绝对路径的意思是从根节点中选择//相对路径意味着从任何位置选择一个节点,而不管它们的位置

Xpath路径示例

定位节点

#查找html下的body下的form下的所有input节点/html/body/form/input#查找所有input节点//input

通配符*选择未知节点

#查找form节点下的所有节点//form/*#查找所有节点//*#查找所有input节点(input至少有爷爷辈亲戚节点)//*/input

二、使用索引(这是我自己的理解)

如果在过滤元素时有多个节点,但是我们要确定唯一的节点。您可以使用类似于列表索引的方法进行精确定位。

案例

#定位 第8个td下的 第2个a节点//*/td[7]/a[1]#定位 第8个td下的 第3个span节点//*/td[7]/span[2]#定位 最后一个td下的 最后一个a节点//*/td[last()]/a[last()]

三、使用属性

为了使定位更准确,类似于使用索引,我们需要增加信息量,因此也可以使用属性。 @符号是属性符号

#定位所有包含name属性的input节点//input[@name]#定位含有属性的所有的input节点//input[@*]#定位所有value=2的input节点//input[@value='2']#使用多个属性定位//input[@value='2'][@id='3']或者//input[@value='2' and @id='3']

四、常用功能

除索引和属性外,Xpath还可以使用便捷的功能来提高定位的准确性。以下是一些常用功能:

函数的含义contains(s1,s2)如果s1收录s2,则返回true;否则,返回falsetext()以获取节点中的文本内容starts-with()与实际位置的字符串匹配

应用推广#定位href属性中包含“promote.html”的所有a节点//a[contains(@href,'promote.html')]#元素内的文本为“应用推广”的所有a节点//a[text()='应用推广']#href属性值是以“/ads”开头的所有a节点//a[starts-with(@href,'/ads')]

五、Xpath轴

这部分类似于BeautifulSoup中的同级,父级和子级方法。有时,为了实现定位,有必要进行环形交叉路口,然后七个姨妈和八个姨妈的远亲走来走去,然后他们彼此认识,并且位置就在那里。

轴名称表示祖先选择当前节点的所有祖先(父亲,祖父等)。祖先或自身选择当前节点的所有祖先(父亲,祖父等),而当前节点自己的属性选择全部当前节点的属性子节点选择当前节点节点的所有后代节点选择当前节点的所有后代节点(子节点,孙子节点等),后代或自身选择当前节点的所有后代节点(子节点,孙子节点等),以及当前节点自身的后继节点选择当前节点末尾之后的节点。所有节点的父节点选择当前节点的父节点。兄弟姐妹选择相同级别的所有节点,然后当前节点自身选择当前节点。

六、美团商家信息

在代码中,我提供了一个高科技的api_key,但是如果您过多使用它,则实际上将无法使用它。我建议你自己申请。

#在高德注册,进入控制台http://lbs.amap.com/

广告中几乎没有人知道,对于50岁的阿姨来说,一勺灵芝孢子粉也会像这样改变

这是几十秒内采集中郑州市的数据。

提示:

修改高德api_key

在项目中找到设置,并将GAODEAPIKEY参数修改为您的应用程序编号的api_key。

更改城市

在项目中找到设置,然后将CITY_NAME参数修改为所需的城市采集

运行主程序采集数据

在项目文件夹中找到main.py并运行它以愉快地获取数据并将其保存到data.csv。 查看全部

美团商务信息采集神器! Python 采集所有业务信息

在github上找到一个美团项目,您可以获取指定城市的商业信息,每分钟都有数百种商业信息的数据在您的手,这些信息包括商店名称,地理位置,等级,销售,电话(这就是重点)。

距我更新已经很久了。今天,我写了文章,并附上了这个有价值的项目下载地址。

本文是您自己编写的xpath注释。如果您不想阅读它,可以转到文章底部代码下载地址。

很遗憾该项目是草率编写的。实际上,我不想使用框架,但是花了一天的时间将此项目更改为可以运行的代码。在更改过程中,我再次熟悉了scrapy。决定学习xpath,后来又开始草率地编写一些爬虫。

Python学习交流小组:1004391443,这是python学习者的聚会场所,这里有专家回答问题和共享资源!编辑器还准备了python学习资料。欢迎那些想要学习python编程或改变职业的人,大学生以及那些希望提高工作能力的人加入学习。

除了CSS之外,scrapy的选择器比xpath更好。现在您需要练习使用xpath。

Xpath简介

通常来说,使用id,name,class和其他属性来定位节点可以解决大多数解析需求,但是有时在以下情况下使用Xpath更方便:

没有诸如id,名称,类之类的标签属性,或者文本功能不明显。标签的嵌套级别太复杂。

Xpath是XML Path的简介。基于XML树结构,您可以在整个树中找到目标节点。由于HTML文档本身是标准的XML页面,因此我们可以使用XPath语法来查找页面元素。

Xpath定位方法

一、Xpath路径

符号名称/绝对路径的意思是从根节点中选择//相对路径意味着从任何位置选择一个节点,而不管它们的位置

Xpath路径示例

定位节点

#查找html下的body下的form下的所有input节点/html/body/form/input#查找所有input节点//input

通配符*选择未知节点

#查找form节点下的所有节点//form/*#查找所有节点//*#查找所有input节点(input至少有爷爷辈亲戚节点)//*/input

二、使用索引(这是我自己的理解)

如果在过滤元素时有多个节点,但是我们要确定唯一的节点。您可以使用类似于列表索引的方法进行精确定位。

案例

#定位 第8个td下的 第2个a节点//*/td[7]/a[1]#定位 第8个td下的 第3个span节点//*/td[7]/span[2]#定位 最后一个td下的 最后一个a节点//*/td[last()]/a[last()]

三、使用属性

为了使定位更准确,类似于使用索引,我们需要增加信息量,因此也可以使用属性。 @符号是属性符号

#定位所有包含name属性的input节点//input[@name]#定位含有属性的所有的input节点//input[@*]#定位所有value=2的input节点//input[@value='2']#使用多个属性定位//input[@value='2'][@id='3']或者//input[@value='2' and @id='3']

四、常用功能

除索引和属性外,Xpath还可以使用便捷的功能来提高定位的准确性。以下是一些常用功能:

函数的含义contains(s1,s2)如果s1收录s2,则返回true;否则,返回falsetext()以获取节点中的文本内容starts-with()与实际位置的字符串匹配

应用推广#定位href属性中包含“promote.html”的所有a节点//a[contains(@href,'promote.html')]#元素内的文本为“应用推广”的所有a节点//a[text()='应用推广']#href属性值是以“/ads”开头的所有a节点//a[starts-with(@href,'/ads')]

五、Xpath轴

这部分类似于BeautifulSoup中的同级,父级和子级方法。有时,为了实现定位,有必要进行环形交叉路口,然后七个姨妈和八个姨妈的远亲走来走去,然后他们彼此认识,并且位置就在那里。

轴名称表示祖先选择当前节点的所有祖先(父亲,祖父等)。祖先或自身选择当前节点的所有祖先(父亲,祖父等),而当前节点自己的属性选择全部当前节点的属性子节点选择当前节点节点的所有后代节点选择当前节点的所有后代节点(子节点,孙子节点等),后代或自身选择当前节点的所有后代节点(子节点,孙子节点等),以及当前节点自身的后继节点选择当前节点末尾之后的节点。所有节点的父节点选择当前节点的父节点。兄弟姐妹选择相同级别的所有节点,然后当前节点自身选择当前节点。

六、美团商家信息

在代码中,我提供了一个高科技的api_key,但是如果您过多使用它,则实际上将无法使用它。我建议你自己申请。

#在高德注册,进入控制台http://lbs.amap.com/

广告中几乎没有人知道,对于50岁的阿姨来说,一勺灵芝孢子粉也会像这样改变

这是几十秒内采集中郑州市的数据。

提示:

修改高德api_key

在项目中找到设置,并将GAODEAPIKEY参数修改为您的应用程序编号的api_key。

更改城市

在项目中找到设置,然后将CITY_NAME参数修改为所需的城市采集

运行主程序采集数据

在项目文件夹中找到main.py并运行它以愉快地获取数据并将其保存到data.csv。

详细数据:用户行为分析之数据采集

采集交流 • 优采云 发表了文章 • 0 个评论 • 289 次浏览 • 2020-10-12 09:00

用户行为简介

用户行为分析的主要指标可以概括如下:哪个用户执行了什么操作,在哪里进行了操作,为什么要进行这些操作,通过什么方法,花费了多长时间以及其他问题,归纳为WHO,何时,何地,什么,为什么以及如何?时间。

基于以上5个W和2H,让我们讨论如何实现它们。

WHO,首先,您需要x以获得登录用户的个人信息。用户名,角色等。

何时获取用户访问页面每个模块的时间,开始时间,结束时间等

什么,在获取用户登录页面后已经执行了哪些操作,单击了哪些页面和模块,等等。

为什么,分析用户点击这些模块的目的

如何,用户如何访问系统,网络,APP,小程序等。

HOW TIME,用户访问每个模块多长时间,浏览特定页面等

以上是我们需要获取的所有数据。只有获得相关数据,我们才能分析用户行为。

用户行为数据采集掩埋点

掩埋点通常分为非掩埋点和代码掩埋点。这两个都有各自的优缺点,这里仅作简要介绍:

全掩埋点是一种前端掩埋方法。 SDK嵌入在产品中,这是最统一的掩埋点。关键行为是通过接口配置方法定义的,以完成埋入点采集,这是前端的埋入点方式之一。

优势:

缺点:

作为前端掩埋点,会有一些自然的缺点

代码掩埋点,这也是我们当前使用的掩埋方法。代码埋入点分为前端代码埋入点和后端代码埋入点。前端埋入点类似于完整埋入点,并且还需要嵌入到SDK中。区别在于对于每种事件行为,您需要调用SDK代码,传入必要的事件名称,属性参数等,然后将其发送到后台数据服务器。后端嵌入式点通过调用SDK接口的后端模块将事件和属性发送到后端服务器。

我们使用代码掩埋点,将其分为前端和后端。嵌入是一个特别重要的过程。它是数据的来源。如果数据源存在问题,则数据本身存在问题,分析结果将失去意义。

因为我负责日志检测,即埋入点之后事件日志的检测警报,并通知相应的埋入点开发人员,操作员和产品方面,所以我遇到了很多凹坑,其中大多数是过程。

事件属性具有元数据管理系统,并且行业中的某些服务也具有此结构。通常,首先定义事件和属性,然后掩埋点。原因是需要检查事件日志数据。有必要检查事件是否存在,属性是否丢失,数据是否正常等等。

遇到的坑

数据错误。这种情况很难发现。需要在操作产品的分析中找到它。这也有点不舒服

基于上述想法,让我们谈谈实现的相关技术问题以及如何进行用户行为分析。

数据采集

根据操作定义的嵌入式点接口形式获取的用户访问日志数据,必须预先在后端和前端定义数据存储格式,即字段内容为保存,并且嵌入点数据需要符合协议。格式统一并封装起来,以便于存储和分析。

以下数据采集神器Flume已耗尽。

实时掩埋点数据采集通常有两种方法:

直接触发的日志将发送到指定的HTTP端口,并写入kafka,然后Flume将kafka消耗到HDFS用户访问日志到磁盘,在相应的主机上部署flume代理,并将文件发送到采集记录目录到Kafka,然后将Flume部署到云中以将Kafka数据消耗到HDFS中

然后,Flume 采集系统的安装相对简单,只需两个步骤:

flume配置模板:

a1.sources = source1

a1.sinks = k1

a1.channels = c1

a1.sources.source1.type = org.apache.flume.source.kafka.KafkaSource

a1.sources.source1.channels = c1

a1.sources.source1.kafka.bootstrap.servers = kafka-host1:port1,kafka-host2:port2...

a1.sources.source1.kafka.topics = flume-test

a1.sources.source1.kafka.consumer.group.id = flume-test-group

# Describe the sink

a1.sinks.k1.type = hdfs

a1.sinks.k1.hdfs.path = /tmp/flume/test-data

a1.sinks.k1.hdfs.fileType=DataStream

# Use a channel which buffers events in memory

a1.channels.c1.type = memory

a1.channels.c1.capacity = 100

a1.channels.c1.transactionCapacity = 100

# Bind the source and sink to the channel

a1.sources.source1.channels = c1

a1.sinks.k1.channel = c1 查看全部

用户行为分析数据采集

用户行为简介

用户行为分析的主要指标可以概括如下:哪个用户执行了什么操作,在哪里进行了操作,为什么要进行这些操作,通过什么方法,花费了多长时间以及其他问题,归纳为WHO,何时,何地,什么,为什么以及如何?时间。

基于以上5个W和2H,让我们讨论如何实现它们。

WHO,首先,您需要x以获得登录用户的个人信息。用户名,角色等。

何时获取用户访问页面每个模块的时间,开始时间,结束时间等

什么,在获取用户登录页面后已经执行了哪些操作,单击了哪些页面和模块,等等。

为什么,分析用户点击这些模块的目的

如何,用户如何访问系统,网络,APP,小程序等。

HOW TIME,用户访问每个模块多长时间,浏览特定页面等

以上是我们需要获取的所有数据。只有获得相关数据,我们才能分析用户行为。

用户行为数据采集掩埋点

掩埋点通常分为非掩埋点和代码掩埋点。这两个都有各自的优缺点,这里仅作简要介绍:

全掩埋点是一种前端掩埋方法。 SDK嵌入在产品中,这是最统一的掩埋点。关键行为是通过接口配置方法定义的,以完成埋入点采集,这是前端的埋入点方式之一。

优势:

缺点:

作为前端掩埋点,会有一些自然的缺点

代码掩埋点,这也是我们当前使用的掩埋方法。代码埋入点分为前端代码埋入点和后端代码埋入点。前端埋入点类似于完整埋入点,并且还需要嵌入到SDK中。区别在于对于每种事件行为,您需要调用SDK代码,传入必要的事件名称,属性参数等,然后将其发送到后台数据服务器。后端嵌入式点通过调用SDK接口的后端模块将事件和属性发送到后端服务器。

我们使用代码掩埋点,将其分为前端和后端。嵌入是一个特别重要的过程。它是数据的来源。如果数据源存在问题,则数据本身存在问题,分析结果将失去意义。

因为我负责日志检测,即埋入点之后事件日志的检测警报,并通知相应的埋入点开发人员,操作员和产品方面,所以我遇到了很多凹坑,其中大多数是过程。

事件属性具有元数据管理系统,并且行业中的某些服务也具有此结构。通常,首先定义事件和属性,然后掩埋点。原因是需要检查事件日志数据。有必要检查事件是否存在,属性是否丢失,数据是否正常等等。

遇到的坑

数据错误。这种情况很难发现。需要在操作产品的分析中找到它。这也有点不舒服

基于上述想法,让我们谈谈实现的相关技术问题以及如何进行用户行为分析。

数据采集

根据操作定义的嵌入式点接口形式获取的用户访问日志数据,必须预先在后端和前端定义数据存储格式,即字段内容为保存,并且嵌入点数据需要符合协议。格式统一并封装起来,以便于存储和分析。

以下数据采集神器Flume已耗尽。

实时掩埋点数据采集通常有两种方法:

直接触发的日志将发送到指定的HTTP端口,并写入kafka,然后Flume将kafka消耗到HDFS用户访问日志到磁盘,在相应的主机上部署flume代理,并将文件发送到采集记录目录到Kafka,然后将Flume部署到云中以将Kafka数据消耗到HDFS中

然后,Flume 采集系统的安装相对简单,只需两个步骤:

flume配置模板:

a1.sources = source1

a1.sinks = k1

a1.channels = c1

a1.sources.source1.type = org.apache.flume.source.kafka.KafkaSource

a1.sources.source1.channels = c1

a1.sources.source1.kafka.bootstrap.servers = kafka-host1:port1,kafka-host2:port2...

a1.sources.source1.kafka.topics = flume-test

a1.sources.source1.kafka.consumer.group.id = flume-test-group

# Describe the sink

a1.sinks.k1.type = hdfs

a1.sinks.k1.hdfs.path = /tmp/flume/test-data

a1.sinks.k1.hdfs.fileType=DataStream

# Use a channel which buffers events in memory

a1.channels.c1.type = memory

a1.channels.c1.capacity = 100

a1.channels.c1.transactionCapacity = 100

# Bind the source and sink to the channel

a1.sources.source1.channels = c1

a1.sinks.k1.channel = c1

解决方案:广州美图图片采集神器服务为先

采集交流 • 优采云 发表了文章 • 0 个评论 • 328 次浏览 • 2020-09-04 22:21

广州美图采集神器服务至上

因此,在科学技术日新月异的时代,全图水印的去除越来越困难,例如随机位置。一些新闻,摄影和其他行业需要大量的图片,时间紧迫。选择Morning Domain专业水印去除软件。速度快,效果好,受到了客户的好评。

广州美图采集神器服务至上

我的朋友问Chenyudata 采集器是否可以采集图片,我当然可以。每个人可能都使用过晨域数据采集器批处理采集 文章数据,但是有时我们还需要采集一些图片,我们也可以使用晨域数据采集器来完成,方法是同样,这也非常简单。下面将介绍使用早晨域图片采集器 采集瀑布流网站图片的方法(以首页图片采集为例)。

水印类别识别算法可以通过程序区分和识别图片水印的不同类别,从而减轻了人工对水印进行分类的麻烦。识别准确率一般在99%左右,也就是说,千张图片中只有几张不能被准确识别。难以识别的单个水印的识别准确率也达到95%以上。

早晨域网站 采集系统针对不同行业的用户的应用需求,目的是访问Internet,并在用户定义的规则下从Internet获得指定的网站信息。获取的信息可以存储在数据库中,也可以直接发送到指定的列,以实现网站信息的及时更新和数据量的增加。

对于特定种类的水印,需要花一些时间来编写删除算法以达到最佳效果,然后分批删除它。与PS不同,请不要在几分钟后查看效果图。由于需要编写删除算法,因此仅接受超过1000页的项目。

广州美图Picture 采集神器服务是第一项。由于大量的图像处理要求以及Photoshop手动水印的复杂性和低效率,Chenyu Software Studio自20年来一直致力于研究图像算法和批量水印。解。批量水印程序主要包括一些算法,水印去除算法,水印类别识别算法和水印随机位置识别算法。

为图片加水印使外行倍感困扰。从理论上讲可以处理PS,但是如果图片数量较大且工作时间相对紧张,则不适合使用。 Meitu Elimination Pen适用于一些相对简单且不麻烦的处理,但无法实现复杂水印或图片的所需效果。为了解决上述问题,晨宇公司进行了研究,实现了++程序的批处理去除水印,实现了无痕与快速去除的完美结合。 查看全部

广州美图采集神器服务至上

广州美图采集神器服务至上

因此,在科学技术日新月异的时代,全图水印的去除越来越困难,例如随机位置。一些新闻,摄影和其他行业需要大量的图片,时间紧迫。选择Morning Domain专业水印去除软件。速度快,效果好,受到了客户的好评。

广州美图采集神器服务至上

我的朋友问Chenyudata 采集器是否可以采集图片,我当然可以。每个人可能都使用过晨域数据采集器批处理采集 文章数据,但是有时我们还需要采集一些图片,我们也可以使用晨域数据采集器来完成,方法是同样,这也非常简单。下面将介绍使用早晨域图片采集器 采集瀑布流网站图片的方法(以首页图片采集为例)。

水印类别识别算法可以通过程序区分和识别图片水印的不同类别,从而减轻了人工对水印进行分类的麻烦。识别准确率一般在99%左右,也就是说,千张图片中只有几张不能被准确识别。难以识别的单个水印的识别准确率也达到95%以上。

早晨域网站 采集系统针对不同行业的用户的应用需求,目的是访问Internet,并在用户定义的规则下从Internet获得指定的网站信息。获取的信息可以存储在数据库中,也可以直接发送到指定的列,以实现网站信息的及时更新和数据量的增加。

对于特定种类的水印,需要花一些时间来编写删除算法以达到最佳效果,然后分批删除它。与PS不同,请不要在几分钟后查看效果图。由于需要编写删除算法,因此仅接受超过1000页的项目。

广州美图Picture 采集神器服务是第一项。由于大量的图像处理要求以及Photoshop手动水印的复杂性和低效率,Chenyu Software Studio自20年来一直致力于研究图像算法和批量水印。解。批量水印程序主要包括一些算法,水印去除算法,水印类别识别算法和水印随机位置识别算法。

为图片加水印使外行倍感困扰。从理论上讲可以处理PS,但是如果图片数量较大且工作时间相对紧张,则不适合使用。 Meitu Elimination Pen适用于一些相对简单且不麻烦的处理,但无法实现复杂水印或图片的所需效果。为了解决上述问题,晨宇公司进行了研究,实现了++程序的批处理去除水印,实现了无痕与快速去除的完美结合。

解决方案:浙江怎么采集神器服务至上

采集交流 • 优采云 发表了文章 • 0 个评论 • 356 次浏览 • 2020-09-03 21:53

浙江采集神器如何首先服务

晨宇提供数据和图片批处理采集服务,并可以根据客户要求定制采集程序,批量保存指定的网站文字信息,图片和视频,并以目录和文件格式存储由客户指定。客户无需学习任何软件操作。他们只需要提出特定的数据要求并等待成品数据。数据采集程序将检查采集的数据和图片,以确保没有丢失的重复项和错误,并且提交给客户的数据是正确,完整且不可重复的。

浙江采集神器如何首先服务

除了去除图像水印外,该公司还提供诸如整个站点数据采集图像批处理采集视频水印去除等服务。我们的长期合作客户包括服装,鞋子,帽子,行李箱,手表,电子产品,工业用品,交通运输,房地产采集和其他行业。

近年来,我们已经处理了一百多个网站图像水印,包括单水印去除,多水印去除,全图像水印去除,多种水印去除,单水印位置随机,多水印位置随机,情况复杂,效果好,时间短,价格低廉,赢得了客户的好评。

浙江采集人工制品服务是至高无上的,因为分批添加了许多水印,水印是相似的,因此可以分批删除早晨域中各种水印的研究和测试,结果是肯定的。 Chenyu开发了一种通用的多图像抠像算法。输入带水印的图片时,它可以自动确定图像的“前景”(水印)遮罩和“背景”(原创图像),从而完美地去除和恢复图像。原创图像的颜色和图案。

近年来,随着科学技术的飞速发展,越来越多的人开始意识到,因此,通常我们在社交软件中看到的图片或视频都会带有水印。如果要添加这些内容,则将保存图片或视频,但是看到水印可能不是特别好。此时,您要删除水印吗?如何快速删除水印?

浙江采集伪影服务是至高无上的,图片批处理水印软件使用混沌序列算法,该算法不仅易于生成水印特征,而且具有对初始条件敏感的优势。由于嵌入检测和提取水印的特征,混沌序列算法的初始值更加简单实用。根据混沌序列脱水算法的这些优点,混沌序列直接用作提取的水印信号。根据混沌对初始值的敏感性和混沌伪随机序列的可靠性,分别使用两种不同的混沌映射模型提取和去除水印图像,以提高批量水印的效果和效率。 查看全部

浙江采集神器如何首先服务

浙江采集神器如何首先服务