内容采集

淄博网站优化中内容采集几个小技巧

采集交流 • 优采云 发表了文章 • 0 个评论 • 301 次浏览 • 2020-08-14 04:49

第一、文章的标题一定要更改

首先文章的标题是用户第一眼听到的,新的文章标题可以吸引用户点击访问页面,提升页面的访问量。同时在一个文章页面中,标题是权重最高的,新的标题可以使当页面能快速被搜索引擎收录。

第二、最好采集当下比较热门的信息内容

如果采集的内容都早已讨论多年,很多网民都已看过,再次点击阅读的兴趣就不会很大。另外讨论多年的话题搜索引擎也已经抓取了太多相关的页面,对于类似内容的页面抓取兴趣不会很大。

第三、做好内容再编辑

很多人对于伪原创的理解就是复制一些内容,然后中间插入自己写的内容,保证自己编撰内容的比列就可以了。这样做不是不可以,但疗效还不是最好。最好的是复制的内容按原先的意思自己重新组织语言编撰一遍,虽然这样比较浪费时间和精力,但疗效更好。

内容采集是网站优化中必不可少的一项工作,采集再编辑的好,对网站优化有很大的帮助。所以做好每一个小细节是极其重要的。 查看全部

淄博网站优化的日常维护中,内容和外链是两大法宝,这两点做好后,不害怕网站没有好的排行。而这两点中又以内容更新为重。但真正做网站优化的同学都有这样的感受,每天更新内容,实在是思虑枯竭。这里就少不得要从网上去采集别人的文章内容进行伪原创,但采集内容再编辑也是有一些小技巧的,做的好可以使文章快速被收录。

第一、文章的标题一定要更改

首先文章的标题是用户第一眼听到的,新的文章标题可以吸引用户点击访问页面,提升页面的访问量。同时在一个文章页面中,标题是权重最高的,新的标题可以使当页面能快速被搜索引擎收录。

第二、最好采集当下比较热门的信息内容

如果采集的内容都早已讨论多年,很多网民都已看过,再次点击阅读的兴趣就不会很大。另外讨论多年的话题搜索引擎也已经抓取了太多相关的页面,对于类似内容的页面抓取兴趣不会很大。

第三、做好内容再编辑

很多人对于伪原创的理解就是复制一些内容,然后中间插入自己写的内容,保证自己编撰内容的比列就可以了。这样做不是不可以,但疗效还不是最好。最好的是复制的内容按原先的意思自己重新组织语言编撰一遍,虽然这样比较浪费时间和精力,但疗效更好。

内容采集是网站优化中必不可少的一项工作,采集再编辑的好,对网站优化有很大的帮助。所以做好每一个小细节是极其重要的。

如何使采集的内容也有价值

采集交流 • 优采云 发表了文章 • 0 个评论 • 315 次浏览 • 2020-08-14 02:28

第二,排版方法要进行优化。采集别人的内容不能否将他人的网页排版也同样采集过来,这就等于复制了一个网页,显然会被百度觉得在剽窃或则作弊,同时也给用户带来不好的现象。对于排版而言,首先要结合自身网站整体的风格进行排版,然后要尽可能的降低广告图片或则其他的垃圾内容,让采集的内容愈加显现,这样可以实现网页的差异化排版。在这里一定要使采集的内容干净整洁,毕竟作为一个新网站,此时应用大量的广告其实没必要,因为无论是你网站的排行,还是点击率都极低,即使使用了百度广告联盟也不会给网站带来利润,所以此时关键要将网页内容排版进行优化,使可读性提高。

第三,采集的内容要尽可能的新鲜。现在互联网的信息更新速率很快,如果你的网站所采集的内容十分的旧,一方面同样的内容在网站上太多,难以得到用户的追捧,另一方面也很难获得收录,以及给予一定的排行。所以采集的内容一定要新鲜,因为此时的内容被转载的次数并不多,如果你提早采集,那么就有可能被百度收录,这样才能够起到较好的优化疗效。通常采集的内容不能够超过两天,尽量采集的内容是在一天之内的内容。当然那些内容采集之后,也须要经过前面两步工作的加工,这样就能明显提高内容的价值,并就能提高收录的可能性。

第四,适当的降低一些图片,同时还须要在图片中将Alt属性的内容填充。之所以如此做,可以利用图片来提高百度的收录,因为现今百度对于有Alt属性内容的图片具有较高的收录效率。而且内容上降低相应的图片,也才能有效提高用户的阅读体验。当然这儿的图片最好具有一定的原创性,或者图片的内涵要才能和内容具有一致性,千万不能否是一个技术类的文章却使用了大量美眉的图片,这样反倒会给内容带来极大的负面影响。 查看全部

第一,对标题和关键词、描述进行更改。这是最至少的操作,如果这种不改,很快都会被百度认定是剽窃,于是网站内容很难被百度收录,同时即使被收录,那么用户听到和别的网站一模一样的内容,再加上你的内容排行在后,显然得到的点击可能性极低。况且随着百度算法的进步,这种纯粹的剽窃采集模式,显然早已不合时宜。在这里将标题和关键词以及描述进行更改,一定要重视和上面的内容保持一致,而且还须要规避标题党的问题,内容和标题具有统一性,同时还须要具有一定的创新性,这样有助于吸引用户点击。

第二,排版方法要进行优化。采集别人的内容不能否将他人的网页排版也同样采集过来,这就等于复制了一个网页,显然会被百度觉得在剽窃或则作弊,同时也给用户带来不好的现象。对于排版而言,首先要结合自身网站整体的风格进行排版,然后要尽可能的降低广告图片或则其他的垃圾内容,让采集的内容愈加显现,这样可以实现网页的差异化排版。在这里一定要使采集的内容干净整洁,毕竟作为一个新网站,此时应用大量的广告其实没必要,因为无论是你网站的排行,还是点击率都极低,即使使用了百度广告联盟也不会给网站带来利润,所以此时关键要将网页内容排版进行优化,使可读性提高。

第三,采集的内容要尽可能的新鲜。现在互联网的信息更新速率很快,如果你的网站所采集的内容十分的旧,一方面同样的内容在网站上太多,难以得到用户的追捧,另一方面也很难获得收录,以及给予一定的排行。所以采集的内容一定要新鲜,因为此时的内容被转载的次数并不多,如果你提早采集,那么就有可能被百度收录,这样才能够起到较好的优化疗效。通常采集的内容不能够超过两天,尽量采集的内容是在一天之内的内容。当然那些内容采集之后,也须要经过前面两步工作的加工,这样就能明显提高内容的价值,并就能提高收录的可能性。

第四,适当的降低一些图片,同时还须要在图片中将Alt属性的内容填充。之所以如此做,可以利用图片来提高百度的收录,因为现今百度对于有Alt属性内容的图片具有较高的收录效率。而且内容上降低相应的图片,也才能有效提高用户的阅读体验。当然这儿的图片最好具有一定的原创性,或者图片的内涵要才能和内容具有一致性,千万不能否是一个技术类的文章却使用了大量美眉的图片,这样反倒会给内容带来极大的负面影响。

javascript 分页 如何采集内容

采集交流 • 优采云 发表了文章 • 0 个评论 • 347 次浏览 • 2020-08-13 21:30

:1108/eol_fenye.php?url=

复制代码

这样的地址,url参数就是踩到的内容页地址

外部php文件处理分页,根据原网站的分页规律生成优采云可采集的分页代码,输出原网站的源码+生成的分页代码,这样优采云就可以采集了

需要本地搭建php运行环境,有很多一键安装的集成包,我用的是discuz的ComsenzEXP,下载网站

安装后,要把php文件放在网站运行的目录里,ComsenzEXP默认C:\ComsenzEXP\wwwroot,把压缩包解压后上面的eol_fenye.php文件放在这儿即可

文件访问地址就是:1108/eol_fenye.php,要加url参数,:1108/eol_fenye.php?url=,可以看见分页疗效

外部插口我还不熟悉,获取源码的方法也可能会出现问题,路乱码等,需要学习改进,路有问题可以联系我

采集规则,分页区域设置见规则

php文件压缩包 查看全部

用外部的php文件处理下,就是把采集的内容页作为外部的php文件的递交参数,用自定义的方法把组合成

:1108/eol_fenye.php?url=

复制代码

这样的地址,url参数就是踩到的内容页地址

外部php文件处理分页,根据原网站的分页规律生成优采云可采集的分页代码,输出原网站的源码+生成的分页代码,这样优采云就可以采集了

需要本地搭建php运行环境,有很多一键安装的集成包,我用的是discuz的ComsenzEXP,下载网站

安装后,要把php文件放在网站运行的目录里,ComsenzEXP默认C:\ComsenzEXP\wwwroot,把压缩包解压后上面的eol_fenye.php文件放在这儿即可

文件访问地址就是:1108/eol_fenye.php,要加url参数,:1108/eol_fenye.php?url=,可以看见分页疗效

外部插口我还不熟悉,获取源码的方法也可能会出现问题,路乱码等,需要学习改进,路有问题可以联系我

采集规则,分页区域设置见规则

php文件压缩包

英文谷歌优化:熊掌号:SEO重复内容与采集站, 会被惩罚吗, 答案在这里!

采集交流 • 优采云 发表了文章 • 0 个评论 • 289 次浏览 • 2020-08-12 16:43

1、百度究竟是否会惩罚重复内容

这里首先须要明晰的是重复内容与采集站点,还是有一定区别的,目前来讲,百度对于重复内容并没有显著的严打征兆,也可以如此理解,百度对重复内容是不会惩罚的。

虽然这么好多SEO专家,在做网站诊断的时侯还会讨论外部站点重复内容的数目问题,正常来讲会通过站长工具来统计是否被附送原文链接!

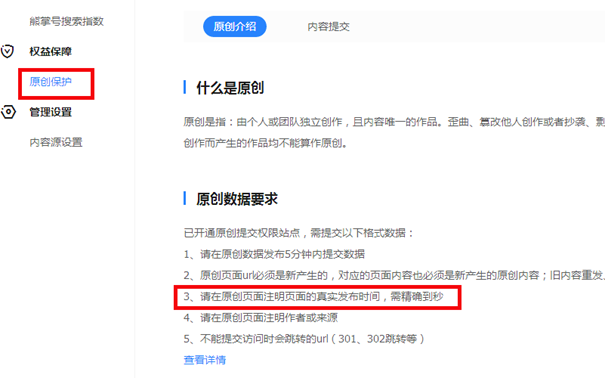

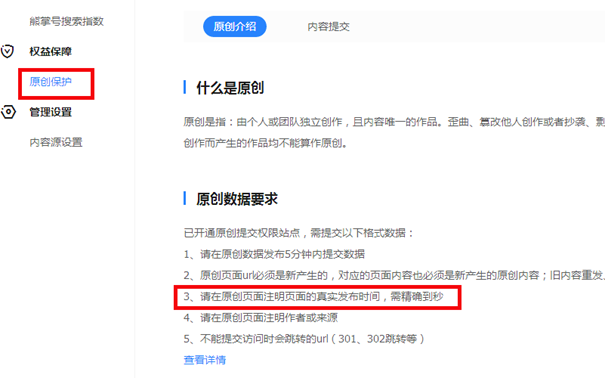

这里你们始终苦恼的问题:文章被转发后,排名比自己的高,百度太明晰仍然在企图解决这个问题,但仍在测试阶段,这点我们可以在近来推出的熊掌号看出希望,有权限的站长,可以在熊掌号下的原创保护递交原创内容,其中太非常一点就是文章发布的时间须要精确到秒:

这是一个太明晰的讯号,拥有原创保护的站点,提交链接一旦初审通过,在移动端的搜索诠释上都会加注原创标签,排名自然都会比转发文章高。

2、采集内容排行为何这么高

这上面的采集内容,应该是一分为二的,主要有下边两种情况:

权威站点转发

整站采集

权威站点转发,在百度推出熊掌号后,会得到显著的改善,那么百度为何给与这部份站点的转发内容很高的排行,这与站点权威度以及原创比列有一定关系,同时为了更好的把优质文章展现今搜索结果页面,从信息传播的角度也是可以理解的,并且权威站点的转发,都会附送版权链接,给新站也是完善友好的外部链接。

整站采集就完全不同了,大批量的采集内容,虽然会保持网站有持续更新的频度,同时也会发觉收录还不错,但采集内容几乎没有排行,这也是目前新闻外链能够存活的一点点理由!

在百度推出飓风算法后,很明晰的心态就是严厉严打恶劣采集站点,看来日后连收录就会成为泡影。

3、内部重复内容是否会被惩罚

对于这个问题目前百度抒发的相对模糊,在近来推出的清风算法中,百度指出不要过多的优化标题,以关键词堆积等方式提升排行,言外之意,标题不要过分重复。

早前也有部份SEO专家表明:

利用反义词或是变相的关键词作为标题制造多个页面,来覆盖关键词目前来讲是不被倡导的,尽量精简到一篇文章中,比如:

大豆的功效与作用

大豆的营养价值

这两个标题,在多个小吃网站你会看见就会有独立的页面存在,但就其内容而言,答案几乎太相仿,百度会希望你们把这两个问题融合在一起,比如:大豆的营养价值,它的功效与作用有什么?

总结:SEO是一种策略,特别是面对重复内容与采集内容的时侯,有的时侯很难判定,很多站长走在临界点,如果你有更多关于重复内容的问题,欢迎留言评论! 查看全部

重复内容是SEO行业仍然关注的问题,重复内容究竟会不会被搜索引擎惩罚,这是一个被常常讨论的话题,百度近来对内容采集站点进行大批量的降权,但仍有太同事发觉自己的文章被转载,排名仍然比自己的原创高,那么互联网上这么多的重复内容,百度是怎样对待的呢?

1、百度究竟是否会惩罚重复内容

这里首先须要明晰的是重复内容与采集站点,还是有一定区别的,目前来讲,百度对于重复内容并没有显著的严打征兆,也可以如此理解,百度对重复内容是不会惩罚的。

虽然这么好多SEO专家,在做网站诊断的时侯还会讨论外部站点重复内容的数目问题,正常来讲会通过站长工具来统计是否被附送原文链接!

这里你们始终苦恼的问题:文章被转发后,排名比自己的高,百度太明晰仍然在企图解决这个问题,但仍在测试阶段,这点我们可以在近来推出的熊掌号看出希望,有权限的站长,可以在熊掌号下的原创保护递交原创内容,其中太非常一点就是文章发布的时间须要精确到秒:

这是一个太明晰的讯号,拥有原创保护的站点,提交链接一旦初审通过,在移动端的搜索诠释上都会加注原创标签,排名自然都会比转发文章高。

2、采集内容排行为何这么高

这上面的采集内容,应该是一分为二的,主要有下边两种情况:

权威站点转发

整站采集

权威站点转发,在百度推出熊掌号后,会得到显著的改善,那么百度为何给与这部份站点的转发内容很高的排行,这与站点权威度以及原创比列有一定关系,同时为了更好的把优质文章展现今搜索结果页面,从信息传播的角度也是可以理解的,并且权威站点的转发,都会附送版权链接,给新站也是完善友好的外部链接。

整站采集就完全不同了,大批量的采集内容,虽然会保持网站有持续更新的频度,同时也会发觉收录还不错,但采集内容几乎没有排行,这也是目前新闻外链能够存活的一点点理由!

在百度推出飓风算法后,很明晰的心态就是严厉严打恶劣采集站点,看来日后连收录就会成为泡影。

3、内部重复内容是否会被惩罚

对于这个问题目前百度抒发的相对模糊,在近来推出的清风算法中,百度指出不要过多的优化标题,以关键词堆积等方式提升排行,言外之意,标题不要过分重复。

早前也有部份SEO专家表明:

利用反义词或是变相的关键词作为标题制造多个页面,来覆盖关键词目前来讲是不被倡导的,尽量精简到一篇文章中,比如:

大豆的功效与作用

大豆的营养价值

这两个标题,在多个小吃网站你会看见就会有独立的页面存在,但就其内容而言,答案几乎太相仿,百度会希望你们把这两个问题融合在一起,比如:大豆的营养价值,它的功效与作用有什么?

总结:SEO是一种策略,特别是面对重复内容与采集内容的时侯,有的时侯很难判定,很多站长走在临界点,如果你有更多关于重复内容的问题,欢迎留言评论!

新浪微博内容数据采集爬虫如何写

采集交流 • 优采云 发表了文章 • 0 个评论 • 351 次浏览 • 2020-08-12 12:31

SinaSpider-基于scrapy和redis的分布式微博爬虫。SinaSpider主要爬取新浪微博的个人信息、微博数据、关注和粉丝。数据库设置Information、Tweets、Follows、Fans四张表。爬虫框架使用Scrapy,使用scrapy_redis和Redis实现分布式。此项目实现将单机的新浪微博爬虫重构成分布式爬虫。

sina_reptile-这是一个关于sina微博的爬虫,采用python开发,并更改了其sdk中的bug,采用mongodb储存,实现了多进程爬取任务。获取新浪微博1000w用户的基本信息和每位爬取用户近来发表的50条微博,使用python编撰,多进程爬取,将数据储存在了mongodb中

sina_weibo_crawler-基于urlib2及beautifulSoup实现的微博爬虫系统。利用urllib2加beautifulsoup爬取新浪微博,数据库采用mongodb,原创关系以txt文件储存,原创内容以csv方式储存,后期直接插入mongodb数据库

sina-weibo-crawler-方便扩充的新浪微博爬虫。WCrawler.crawl()函数只须要一个url参数,返回的用户粉丝、关注上面都有url,可以向外扩充爬取,并且也可以自定义一些过滤规则。

weibo_crawler-基于Python、BeautifulSoup、mysql微博搜索结果爬取工具。本工具使用模拟登陆来实现微博搜索结果的爬取。

SinaMicroblog_Creeper-Spider_VerificationCode-新浪微博爬虫,获得每位用户和关注的,粉丝的用户id存入xml文件中,BFS,可以模拟登录,模拟登录中的验证码会抓取出来使用户输入。

不过在这之前,一些功能和句型药了解,比如list,dict,切片,条件判定,文件读写操作等;

网页的基本知识,分析语言能力要具备;开发者工具会熟练运用; 查看全部

在不同的峰会和问答中,经常会遇见新浪微博的数据采集爬虫程序如何写,或是早已完成了某部份前面须要协助帮助如何做,楚江数据结合网上资料整理了几个微博爬虫开源项目。

SinaSpider-基于scrapy和redis的分布式微博爬虫。SinaSpider主要爬取新浪微博的个人信息、微博数据、关注和粉丝。数据库设置Information、Tweets、Follows、Fans四张表。爬虫框架使用Scrapy,使用scrapy_redis和Redis实现分布式。此项目实现将单机的新浪微博爬虫重构成分布式爬虫。

sina_reptile-这是一个关于sina微博的爬虫,采用python开发,并更改了其sdk中的bug,采用mongodb储存,实现了多进程爬取任务。获取新浪微博1000w用户的基本信息和每位爬取用户近来发表的50条微博,使用python编撰,多进程爬取,将数据储存在了mongodb中

sina_weibo_crawler-基于urlib2及beautifulSoup实现的微博爬虫系统。利用urllib2加beautifulsoup爬取新浪微博,数据库采用mongodb,原创关系以txt文件储存,原创内容以csv方式储存,后期直接插入mongodb数据库

sina-weibo-crawler-方便扩充的新浪微博爬虫。WCrawler.crawl()函数只须要一个url参数,返回的用户粉丝、关注上面都有url,可以向外扩充爬取,并且也可以自定义一些过滤规则。

weibo_crawler-基于Python、BeautifulSoup、mysql微博搜索结果爬取工具。本工具使用模拟登陆来实现微博搜索结果的爬取。

SinaMicroblog_Creeper-Spider_VerificationCode-新浪微博爬虫,获得每位用户和关注的,粉丝的用户id存入xml文件中,BFS,可以模拟登录,模拟登录中的验证码会抓取出来使用户输入。

不过在这之前,一些功能和句型药了解,比如list,dict,切片,条件判定,文件读写操作等;

网页的基本知识,分析语言能力要具备;开发者工具会熟练运用;

B2B 产品方法论(三):内容产出的流程以及内容团队的营运、协作与 SOP

采集交流 • 优采云 发表了文章 • 0 个评论 • 240 次浏览 • 2020-08-11 19:19

本文大纲:

第一篇先概论了用户下降&内容行销的方法论,介绍 SaaS 企业工具的产品核心、To B 与 To C 营销的最大差别在于决策链上多了“评估”这个环节。

第二篇则是进一步谈 B2B“行销与营运”的误区,不建议追求大量爆光与传播,应追求的是“转化”,以及怎样运用 Inbound Marketing 的方法,让企业用户觉得你是个值得信任的品牌。

【运营】透过一系列步骤去“生产内容”,目的是提升产品的价值,让用户的粘度、活跃度提高。

运营主要可分为两个阶段:

拉新(Leads)、使用(User)、付费转化(Active)用户管理和维系(VIP, Referral)

而接下来的第三篇,是 Inbound Marketing 概念的应用呈现,也就是也称的“内容行销”。

我会用一整篇,分享我在 JANDI 的“内容产出流程”,每一个环节为何这样设计,用了什么工具与技巧来协助我,以及怎样模式化运作。

内容行销的五个营运流程基本上可以分为“五步骤”:

采集:用户需求剖析,定位内容营运目标专题:将用户需求,转为产品需求创作/编辑/审核:模式化生产(以 Airtable 作为专案追踪与数据资料库)推送/排程:别急着喝棉花糖,等待时机快速测试/获取回馈/保持互动:建立社群、培养用户行惯一、采集:用户需求剖析,定位内容营运目标

第一个阶段,我们必须先“采集”,但这个采集的受词并不是内容素材,而是“用户需求”。

生产内容之前,我们必须先了解企业目前所处之环境、有多少资源、要达到哪些目标,才能开始行动。

根据现阶段的营运目标,进行“用户需求剖析”,定位受众的轮廓,找出对应的内容偏好。确立内容标准(背景与内容?如何与企业品牌价直观联结?文章撰写方向?),并且订出本次内容营运的目标(流量、转化的指标)用户需求剖析:用户场景问题解决方案

用户需求剖析,建议使用思维导图软件,快速展开,并且有效地排序优先次序。

用户需求剖析,可用“用户场景问题解决方案”的步骤来层层展开

二、专题:将用户需求,转为产品需求

第二个阶段,将上一阶段发散完的“用户需求”,收敛成“产品需求”。

以内容行销这个环节来看的话,其实就是“内容规划”。

而在 JANDI 内,我们称为——专题。

也就是在一段时间内,我们的内容生产必须符合此方向,让“内容有包围性”,也使我们的用户读者,可以更全面性的了解这议程。

举例来说,在 JANDI,我们每隔几个月会根据当时的行销策略、研究用户状况、时间与环境趋势,推出相对应的专题,例如 2018 年尾时,搭配圣诞,推出了以“转型、除旧布新”为主题的内容专题。

JANDI 内容专题的草案文件

收录:背景与内容、与公司品牌价值观的联结、时间、子标题、预计日程…等等资讯

三、创作/编辑/审核:模式化生产(Airtable)

再来是第三个阶段,当专题设定完成后,就有了个方向可以去采集内容素材,开始撰写内容了!

这个阶段是个漫长的流程,既然有流程就有模式化的流程图:

这是我们内部内容生产的流程图,做出 SOP 才能够有效益的模式化!

FAQ:为什么用 Airtable?

因为 Airtable 算是个全方为的智慧型资料库了,除了最基本的资料库检视之外,还有月历检视(一览文章的预定发布日),看板式检视(快速了解每位内容的状态,哪些 Delay 要处理,哪些还没画图)。

甚至,还能配合函数,将 utm 网址自动化产出,将一个文章设定一个 ID,就能手动形成对应的 utm 追踪网址。

不只是资料库的标准备配:“分析数据”好用,还能做专案管理,虽然介面全英语,但真的无可取代,有空的同学也可以试试玩儿(百分之九十九使你离开一点都不智慧的 Google Sheet XDD):点此使用Airtable

Airtable(一):先透过月历检视,找到自己被分配到的文章,查看日期是否可以接受,再填写自己预计完成的草稿日期(至少提早预计发布日两天)

Airtable(二),左图:看板式检视;右图:透过函示可以直接自动化 utm 追踪码

我们整篇文章,都会有一个专属 ID ,例如图中“TWM_Productivity_062”(台湾,Medium,Productivity 系列文章第 62 号),而我们的 CTA 的 utm 追踪码是:(网址会导到官网的用户注册页面)

#/zh-tw/campaign?campaignName=XXX&campaignSource=medium&campaignMedium=blog&campaignDest=register

其中的 XXX 就是该篇文章的 ID,这是我们公司自行开发的追踪系统(类似 Google Analytics),若有人点击此网址时,后台会纪录他以后的行为:

转化率指标:Register:多少人点击此网址;Confirmation Email:注册成功

这边分享一下 Airtable 自动化的函式(Formula),可以拿去参考,如何构建自动化的一串文字(我个人当时是研究了 1 个多小时才成功找到方式):

(“#/zh-tw/campaign?campaignName=”) & {文章 ID} & T(“&campaignSource=medium&campaignMedium=blog&campaignDest=register”)

Hint:{这边是变数},其他都是常数。

四、推送/排程:别急着喝棉花糖,等待时机!

第四个阶段,并没哪些很非常的要点,算是标准流程——根据大家目标用户的使用习惯,找到相对应的时间、管道,推送给她们。记住,不是写完就发,别急着喝棉花糖啊。

以我们自己来说,拥有主要下述四个管线,推送我们的新内容:

当然,还有跟其他外部媒体合作转载文章这个管线,但这等我在下一篇“谈数据”的时侯,再来好好谈谈“合作转载”需要注意的事。

五、快速测试/获取回馈/保持互动:建立社群,培养用户行惯!

最后,第五个阶段,就是简单粗鲁地快速测试而且迭代。

与用户保持互动,获取回馈,目的是“培养用户参与内容”的习惯。

切记,至少要有一个推播内容的管线,是可以与用户保持高频度互动的。

像是我们的互动管线就是“脸书f粉丝专页”,会在每一次专题的开始与结尾,透过优采云包&脸书机器人的方法,与用户保持互动,并且快速测试,获取回馈。

JANDI 2018 年末专题《如何变革,除旧布新?》的结尾优采云包策略

结论:内容行销,尽可能模式化,才有迹可循

“内容行销”是个公司由内,把自己的品牌价值观往外营运的过程,当然一个人也能做到,但在 B2B 的场景下,这并非一个人可以“完成”的事。

毕竟在每一个环节,都须要有人好好把关。我此次分享的“五步骤”,基本上每一个步骤都须要一个负责人(团队),整个流程才能完整。

一开始,我们团队只有少少的人,每个环节只能勉勉强强做到关键项目,没有办法顾忌到细节。

但如今,团队早已逐渐成熟,开始有了负责专题制做、社群互动与优采云包、用户剖析的专业靠谱朋友,所以整个内容营运的流程能够稳定发挥,持续输出品牌价值观的内容。

最后,尽可能地使流程弄成一个 SOP 模式化,无论使你们有迹可寻、更好协作之外,也是为了未来的新进朋友,能有个路径能快速上手。

就像我这系列方法论,也是希望使有须要的朋友们,能有迹可寻,找到参考运用在自己的工作上,不一定立刻起效,但起码有个方式可以参考,可以去验证。 查看全部

内容的产出可以分为五个阶段:采集用户需求,进行剖析 → 收敛需求成专题 → 模式化生产内容 → 排程推送管线 → 快速测试与迭代,建立社群培养用户习惯。

本文大纲:

第一篇先概论了用户下降&内容行销的方法论,介绍 SaaS 企业工具的产品核心、To B 与 To C 营销的最大差别在于决策链上多了“评估”这个环节。

第二篇则是进一步谈 B2B“行销与营运”的误区,不建议追求大量爆光与传播,应追求的是“转化”,以及怎样运用 Inbound Marketing 的方法,让企业用户觉得你是个值得信任的品牌。

【运营】透过一系列步骤去“生产内容”,目的是提升产品的价值,让用户的粘度、活跃度提高。

运营主要可分为两个阶段:

拉新(Leads)、使用(User)、付费转化(Active)用户管理和维系(VIP, Referral)

而接下来的第三篇,是 Inbound Marketing 概念的应用呈现,也就是也称的“内容行销”。

我会用一整篇,分享我在 JANDI 的“内容产出流程”,每一个环节为何这样设计,用了什么工具与技巧来协助我,以及怎样模式化运作。

内容行销的五个营运流程基本上可以分为“五步骤”:

采集:用户需求剖析,定位内容营运目标专题:将用户需求,转为产品需求创作/编辑/审核:模式化生产(以 Airtable 作为专案追踪与数据资料库)推送/排程:别急着喝棉花糖,等待时机快速测试/获取回馈/保持互动:建立社群、培养用户行惯一、采集:用户需求剖析,定位内容营运目标

第一个阶段,我们必须先“采集”,但这个采集的受词并不是内容素材,而是“用户需求”。

生产内容之前,我们必须先了解企业目前所处之环境、有多少资源、要达到哪些目标,才能开始行动。

根据现阶段的营运目标,进行“用户需求剖析”,定位受众的轮廓,找出对应的内容偏好。确立内容标准(背景与内容?如何与企业品牌价直观联结?文章撰写方向?),并且订出本次内容营运的目标(流量、转化的指标)用户需求剖析:用户场景问题解决方案

用户需求剖析,建议使用思维导图软件,快速展开,并且有效地排序优先次序。

用户需求剖析,可用“用户场景问题解决方案”的步骤来层层展开

二、专题:将用户需求,转为产品需求

第二个阶段,将上一阶段发散完的“用户需求”,收敛成“产品需求”。

以内容行销这个环节来看的话,其实就是“内容规划”。

而在 JANDI 内,我们称为——专题。

也就是在一段时间内,我们的内容生产必须符合此方向,让“内容有包围性”,也使我们的用户读者,可以更全面性的了解这议程。

举例来说,在 JANDI,我们每隔几个月会根据当时的行销策略、研究用户状况、时间与环境趋势,推出相对应的专题,例如 2018 年尾时,搭配圣诞,推出了以“转型、除旧布新”为主题的内容专题。

JANDI 内容专题的草案文件

收录:背景与内容、与公司品牌价值观的联结、时间、子标题、预计日程…等等资讯

三、创作/编辑/审核:模式化生产(Airtable)

再来是第三个阶段,当专题设定完成后,就有了个方向可以去采集内容素材,开始撰写内容了!

这个阶段是个漫长的流程,既然有流程就有模式化的流程图:

这是我们内部内容生产的流程图,做出 SOP 才能够有效益的模式化!

FAQ:为什么用 Airtable?

因为 Airtable 算是个全方为的智慧型资料库了,除了最基本的资料库检视之外,还有月历检视(一览文章的预定发布日),看板式检视(快速了解每位内容的状态,哪些 Delay 要处理,哪些还没画图)。

甚至,还能配合函数,将 utm 网址自动化产出,将一个文章设定一个 ID,就能手动形成对应的 utm 追踪网址。

不只是资料库的标准备配:“分析数据”好用,还能做专案管理,虽然介面全英语,但真的无可取代,有空的同学也可以试试玩儿(百分之九十九使你离开一点都不智慧的 Google Sheet XDD):点此使用Airtable

Airtable(一):先透过月历检视,找到自己被分配到的文章,查看日期是否可以接受,再填写自己预计完成的草稿日期(至少提早预计发布日两天)

Airtable(二),左图:看板式检视;右图:透过函示可以直接自动化 utm 追踪码

我们整篇文章,都会有一个专属 ID ,例如图中“TWM_Productivity_062”(台湾,Medium,Productivity 系列文章第 62 号),而我们的 CTA 的 utm 追踪码是:(网址会导到官网的用户注册页面)

#/zh-tw/campaign?campaignName=XXX&campaignSource=medium&campaignMedium=blog&campaignDest=register

其中的 XXX 就是该篇文章的 ID,这是我们公司自行开发的追踪系统(类似 Google Analytics),若有人点击此网址时,后台会纪录他以后的行为:

转化率指标:Register:多少人点击此网址;Confirmation Email:注册成功

这边分享一下 Airtable 自动化的函式(Formula),可以拿去参考,如何构建自动化的一串文字(我个人当时是研究了 1 个多小时才成功找到方式):

(“#/zh-tw/campaign?campaignName=”) & {文章 ID} & T(“&campaignSource=medium&campaignMedium=blog&campaignDest=register”)

Hint:{这边是变数},其他都是常数。

四、推送/排程:别急着喝棉花糖,等待时机!

第四个阶段,并没哪些很非常的要点,算是标准流程——根据大家目标用户的使用习惯,找到相对应的时间、管道,推送给她们。记住,不是写完就发,别急着喝棉花糖啊。

以我们自己来说,拥有主要下述四个管线,推送我们的新内容:

当然,还有跟其他外部媒体合作转载文章这个管线,但这等我在下一篇“谈数据”的时侯,再来好好谈谈“合作转载”需要注意的事。

五、快速测试/获取回馈/保持互动:建立社群,培养用户行惯!

最后,第五个阶段,就是简单粗鲁地快速测试而且迭代。

与用户保持互动,获取回馈,目的是“培养用户参与内容”的习惯。

切记,至少要有一个推播内容的管线,是可以与用户保持高频度互动的。

像是我们的互动管线就是“脸书f粉丝专页”,会在每一次专题的开始与结尾,透过优采云包&脸书机器人的方法,与用户保持互动,并且快速测试,获取回馈。

JANDI 2018 年末专题《如何变革,除旧布新?》的结尾优采云包策略

结论:内容行销,尽可能模式化,才有迹可循

“内容行销”是个公司由内,把自己的品牌价值观往外营运的过程,当然一个人也能做到,但在 B2B 的场景下,这并非一个人可以“完成”的事。

毕竟在每一个环节,都须要有人好好把关。我此次分享的“五步骤”,基本上每一个步骤都须要一个负责人(团队),整个流程才能完整。

一开始,我们团队只有少少的人,每个环节只能勉勉强强做到关键项目,没有办法顾忌到细节。

但如今,团队早已逐渐成熟,开始有了负责专题制做、社群互动与优采云包、用户剖析的专业靠谱朋友,所以整个内容营运的流程能够稳定发挥,持续输出品牌价值观的内容。

最后,尽可能地使流程弄成一个 SOP 模式化,无论使你们有迹可寻、更好协作之外,也是为了未来的新进朋友,能有个路径能快速上手。

就像我这系列方法论,也是希望使有须要的朋友们,能有迹可寻,找到参考运用在自己的工作上,不一定立刻起效,但起码有个方式可以参考,可以去验证。

大数据开发培训须要学习的内容,大数据开发培训课程大纲

采集交流 • 优采云 发表了文章 • 0 个评论 • 191 次浏览 • 2020-08-11 14:25

一、静态页面基础 1颗星

从技术层面来说,该阶段使用的技术代码很简单、易于学习、方便理解。从后期课程层来说,因为我们重点是大数据,但前期须要锻练编程技术与思维。经过我们多年开发和讲课的项目总监剖析,满足这两点,目前市场上最好理解和把握的技术是J2EE,但J2EE又离不开页面技术。所以第一阶段我们的重点是页面技术。采用市场上主流的HTMl+CSS。

二、JavaSE+JavaWeb 2颗星

称为Java基础,由浅入深的技术点、真实商业项目模块剖析、多种储存形式的设计与实现。该阶段是前四个阶段最最重要的阶段,因为前面所有阶段的都要基于此阶段,也是学习大数据紧密度最高的阶段。本阶段将第一次接触团队开发、产出具有前后台(第一阶段技术+第二阶段的技术综合应用)的真实项目。

三、 前端框架 3颗星

前两个阶段的基础上化静为动,可以实现使我们网页内容愈加的丰富,当然假如从市场人员层面来说,有专业的后端设计人员,我们设计本阶段的目标在于后端的技术可以更直观的锻练人的思维和设计能力。同时我们也将第二阶段的中级特点融入到本阶段。使学习者更上一层楼。

四、企业及开发框架 4颗星

从J2EE开发工程师的任职要求来说,该阶段所用到的技术是必须把握,而我们所授的课程是低于市场(市场上主流三大框架,我们进行七大框架技术传授)、而且有真实的商业项目驱动需求文档、概要设计、详细设计、源码测试、部署、安装指南等就会进行讲解。

五、初识大数据 3颗星

描述如下:

该阶段设计是为了使新人才能对大数据有一个相对的大概念如何相对呢?在后置课程JAVA的学习之后才能理解程序在单机的笔记本上是怎样运行的。现在,大数据呢?大数据是将程序运行在大规模机器的集群中处理。大数据其实是要处理数据,所以同样,数据的储存从单机储存变为多机器大规模的集群储存。(你问我哪些是集群?好,我有一大锅饭,我一个人可以喝完,但是要许久,现在我叫你们一起喝。一个人的时侯叫人,人多了呢? 是不是叫人群啊!)

那么大数据可以初略的分为: 大数据储存和大数据处理

所以在这个阶段中呢,我们课程设计了大数据的标准:HADOOP

大数据的运行呢并不是在咋们常常使用的WINDOWS 7或则W10里面,而是

现在使用最广泛的系统:LINUX。

六、大数据数据库 4颗星

描述如下:

该阶段设计是为了使你们在理解大数据怎样处理大规模的数据的同时。简化咋们的编撰程序时间,同时提升读取速率。

怎么简化呢?在第一阶段中,如果须要进行复杂的业务关联与数据挖掘,自行编撰MR程序是十分繁琐的。所以在这一阶段中我们引入了HIVE,大数据中的数据库房。这里有一个关键字,数据库房。我晓得你要问我,所以我先说,数据库房呢用

来做数据挖掘剖析的,通常是一个超大的数据中心,存储这种数据的呢,一般ORACLE,DB2,等小型数据库,这些数据库一般用作实时的在线业务。

总之,要基于数据库房剖析数据呢速率是相对较慢的。但是便捷在于只要熟悉SQL,学习上去相对简单,而HIVE呢就是这样一种工具,基于大数据的SQL查询工具

呐,这一阶段呢还包括HBASE,它为大数据上面的数据库。

纳闷了,不是学了一种称作HIVE的数据“仓库”了么?HIVE是基于MR的所以

查询上去相当慢,HBASE呢基于大数据可以做到实时的数据查询。一个主剖析,

另一个主查询

七、实时数据采集 4颗星

描述如下:

前面的阶段数据来源是基于早已存在的大规模数据集来做的,数据处理与剖析之后

的结果是存在一定延时的,通常处理的数据为前一天的数据。

举例场景:网站防盗链,客户帐户异常,实时征信,遇到这种场景基于前一天的数

据剖析下来之后呢?是否很晚了。所以在本阶段中我们引入了实时的数据采集与分

析。主要包括了:FLUME实时数据采集,采集的来源支持十分广泛,KAFKA数据

数据接收与发送,STORM实时数据处理,数据处理秒级别

八、spark数据剖析 5颗星

描述如下:

同样先说后面的阶段,主要是第一阶段。HADOOP呢在剖析速率上基于MR的大规模数据集相对来说还是很慢的,包括机器学习,人工智能等。而且不适宜做迭代估算。SPARK呢在剖析上是作为MR的取代产品,怎么取代呢? 先说她们的运行机制,HADOOP基于磁盘存储剖析,而SPARK基于内存分析。我这么说你可能不懂,再形象一点,就像你要坐优采云从上海到南京,MR就是绿皮优采云,而SPARK是铁路或则磁悬浮。而SPARK呢是基于SCALA语言开发的,当然对SCALA支持最好,所以课程中先学习SCALA开发语言。什么?又要学另外一种开发语言?不不不!!!我只说一句话:SCALA是基于JAVA做的。

总结:在课程的设计方面,市面上的职位要求技术,基本全覆盖。而且并不是单纯的为了覆盖职位要求,而是本身课程从前到后就是一个完整的大数据项目流程,一环扣一环。

比如从历史数据的储存,分析(HADOOP,HIVE,HBASE),到实时的数据储存(FLUME,KAFKA),分析(STORM,SPARK),这些在真实的项目中都是相互依赖存在的。 查看全部

大数据要学习哪些内容呢?科多大数据带你们来瞧瞧大数据开发课程大纲。

一、静态页面基础 1颗星

从技术层面来说,该阶段使用的技术代码很简单、易于学习、方便理解。从后期课程层来说,因为我们重点是大数据,但前期须要锻练编程技术与思维。经过我们多年开发和讲课的项目总监剖析,满足这两点,目前市场上最好理解和把握的技术是J2EE,但J2EE又离不开页面技术。所以第一阶段我们的重点是页面技术。采用市场上主流的HTMl+CSS。

二、JavaSE+JavaWeb 2颗星

称为Java基础,由浅入深的技术点、真实商业项目模块剖析、多种储存形式的设计与实现。该阶段是前四个阶段最最重要的阶段,因为前面所有阶段的都要基于此阶段,也是学习大数据紧密度最高的阶段。本阶段将第一次接触团队开发、产出具有前后台(第一阶段技术+第二阶段的技术综合应用)的真实项目。

三、 前端框架 3颗星

前两个阶段的基础上化静为动,可以实现使我们网页内容愈加的丰富,当然假如从市场人员层面来说,有专业的后端设计人员,我们设计本阶段的目标在于后端的技术可以更直观的锻练人的思维和设计能力。同时我们也将第二阶段的中级特点融入到本阶段。使学习者更上一层楼。

四、企业及开发框架 4颗星

从J2EE开发工程师的任职要求来说,该阶段所用到的技术是必须把握,而我们所授的课程是低于市场(市场上主流三大框架,我们进行七大框架技术传授)、而且有真实的商业项目驱动需求文档、概要设计、详细设计、源码测试、部署、安装指南等就会进行讲解。

五、初识大数据 3颗星

描述如下:

该阶段设计是为了使新人才能对大数据有一个相对的大概念如何相对呢?在后置课程JAVA的学习之后才能理解程序在单机的笔记本上是怎样运行的。现在,大数据呢?大数据是将程序运行在大规模机器的集群中处理。大数据其实是要处理数据,所以同样,数据的储存从单机储存变为多机器大规模的集群储存。(你问我哪些是集群?好,我有一大锅饭,我一个人可以喝完,但是要许久,现在我叫你们一起喝。一个人的时侯叫人,人多了呢? 是不是叫人群啊!)

那么大数据可以初略的分为: 大数据储存和大数据处理

所以在这个阶段中呢,我们课程设计了大数据的标准:HADOOP

大数据的运行呢并不是在咋们常常使用的WINDOWS 7或则W10里面,而是

现在使用最广泛的系统:LINUX。

六、大数据数据库 4颗星

描述如下:

该阶段设计是为了使你们在理解大数据怎样处理大规模的数据的同时。简化咋们的编撰程序时间,同时提升读取速率。

怎么简化呢?在第一阶段中,如果须要进行复杂的业务关联与数据挖掘,自行编撰MR程序是十分繁琐的。所以在这一阶段中我们引入了HIVE,大数据中的数据库房。这里有一个关键字,数据库房。我晓得你要问我,所以我先说,数据库房呢用

来做数据挖掘剖析的,通常是一个超大的数据中心,存储这种数据的呢,一般ORACLE,DB2,等小型数据库,这些数据库一般用作实时的在线业务。

总之,要基于数据库房剖析数据呢速率是相对较慢的。但是便捷在于只要熟悉SQL,学习上去相对简单,而HIVE呢就是这样一种工具,基于大数据的SQL查询工具

呐,这一阶段呢还包括HBASE,它为大数据上面的数据库。

纳闷了,不是学了一种称作HIVE的数据“仓库”了么?HIVE是基于MR的所以

查询上去相当慢,HBASE呢基于大数据可以做到实时的数据查询。一个主剖析,

另一个主查询

七、实时数据采集 4颗星

描述如下:

前面的阶段数据来源是基于早已存在的大规模数据集来做的,数据处理与剖析之后

的结果是存在一定延时的,通常处理的数据为前一天的数据。

举例场景:网站防盗链,客户帐户异常,实时征信,遇到这种场景基于前一天的数

据剖析下来之后呢?是否很晚了。所以在本阶段中我们引入了实时的数据采集与分

析。主要包括了:FLUME实时数据采集,采集的来源支持十分广泛,KAFKA数据

数据接收与发送,STORM实时数据处理,数据处理秒级别

八、spark数据剖析 5颗星

描述如下:

同样先说后面的阶段,主要是第一阶段。HADOOP呢在剖析速率上基于MR的大规模数据集相对来说还是很慢的,包括机器学习,人工智能等。而且不适宜做迭代估算。SPARK呢在剖析上是作为MR的取代产品,怎么取代呢? 先说她们的运行机制,HADOOP基于磁盘存储剖析,而SPARK基于内存分析。我这么说你可能不懂,再形象一点,就像你要坐优采云从上海到南京,MR就是绿皮优采云,而SPARK是铁路或则磁悬浮。而SPARK呢是基于SCALA语言开发的,当然对SCALA支持最好,所以课程中先学习SCALA开发语言。什么?又要学另外一种开发语言?不不不!!!我只说一句话:SCALA是基于JAVA做的。

总结:在课程的设计方面,市面上的职位要求技术,基本全覆盖。而且并不是单纯的为了覆盖职位要求,而是本身课程从前到后就是一个完整的大数据项目流程,一环扣一环。

比如从历史数据的储存,分析(HADOOP,HIVE,HBASE),到实时的数据储存(FLUME,KAFKA),分析(STORM,SPARK),这些在真实的项目中都是相互依赖存在的。

通过网路爬虫采集大数据

采集交流 • 优采云 发表了文章 • 0 个评论 • 357 次浏览 • 2020-08-11 00:11

在互联网时代,网络爬虫主要是为搜索引擎提供最全面和最新的数据。

在大数据时代,网络爬虫更是从互联网上采集数据的有利工具。目前早已晓得的各类网路爬虫工具早已有上百个,网络爬虫工具基本可以分为 3 类。

本节首先对网路爬虫的原理和工作流程进行简单介绍,然后对网路爬虫抓取策略进行讨论,最后对典型的网路工具进行描述。网络爬虫原理网络爬虫是一种根据一定的规则,自动地抓取 Web 信息的程序或则脚本。

Web 网络爬虫可以手动采集所有其才能访问到的页面内容,为搜索引擎和大数据剖析提供数据来源。从功能上来讲,爬虫通常有数据采集、处理和储存 3 部分功能,如图 1 所示。

图 1 网络爬虫示意

网页中不仅收录供用户阅读的文字信息外,还收录一些超链接信息。

网络爬虫系统正是通过网页中的超链接信息不断获得网路上的其他网页的。网络爬虫从一个或若干初始网页的 URL 开始,获得初始网页上的 URL,在抓取网页的过程中,不断从当前页面上抽取新的 URL 放入队列,直到满足系统的一定停止条件。

网络爬虫系统通常会选择一些比较重要的、出度(网页中链出的超链接数)较大的网站的 URL 作为种子 URL 集合。

网络爬虫系统以这种种子集合作为初始 URL,开始数据的抓取。因为网页中富含链接信息,通过已有网页的 URL 会得到一些新的 URL。

可以把网页之间的指向结构视为一个森林,每个种子 URL 对应的网页是森林中的一棵树的根结点,这样网路爬虫系统就可以按照广度优先搜索算法或则深度优先搜索算法遍历所有的网页。

由于深度优先搜索算法可能会让爬虫系统深陷一个网站内部,不利于搜索比较紧靠网站首页的网页信息,因此通常采用广度优先搜索算法采集网页。

网络爬虫系统首先将种子 URL 放入下载队列,并简单地从队首取出一个 URL 下载其对应的网页,得到网页的内容并将其储存后,经过解析网页中的链接信息可以得到一些新的 URL。

其次,根据一定的网页分析算法过滤掉与主题无关的链接,保留有用的链接并将其倒入等待抓取的 URL 队列。

最后,取出一个 URL,对其对应的网页进行下载,然后再解析,如此反复进行,直到遍历了整个网路或则满足某种条件后才能停止出来。网络爬虫工作流程如图 2 所示,网络爬虫的基本工作流程如下。

1)首先选定一部分种子 URL。

2)将这种 URL 放入待抓取 URL 队列。

3)从待抓取 URL 队列中取出待抓取 URL,解析 DNS,得到主机的 IP 地址,并将 URL 对应的网页下载出来,存储到已下载网页库中。此外,将这种 URL 放进已抓取 URL 队列。

4)分析已抓取 URL 队列中的 URL,分析其中的其他 URL,并且将这种 URL 放入待抓取 URL 队列,从而步入下一个循环。

图 2网路爬虫的基本工作流程

网络爬虫抓取策略Google 和百度等通用搜索引擎抓取的网页数目一般都是以亿为单位估算的。那么,面对这么诸多的网页,通过何种方法能够让网络爬虫尽可能地遍历所有网页,从而尽可能地扩大网页信息的抓取覆盖面,这是网路爬虫系统面对的一个太关键的问题。在网路爬虫系统中,抓取策略决定了抓取网页的次序。

本节首先对网路爬虫抓取策略用到的基本概念做简单介绍。1)网页间关系模型从互联网的结构来看,网页之间通过数目不等的超链接互相联接,形成一个彼此关联、庞大复杂的有向图。

如图 3 所示,如果将网页看成是图中的某一个结点,而将网页中指向其他网页的链接看成是这个结点指向其他结点的边,那么我们很容易将整个互联网上的网页建模成一个有向图。

理论上讲,通过遍历算法遍历该图,可以访问到互联网上几乎所有的网页。

图 3网页关系模型图

2)网页分类从爬虫的角度对互联网进行界定,可以将互联网的所有页面分为 5 个部份:已下载未过期网页、已下载已过期网页、待下载网页、可知网页和不可知网页,如图 4 所示。

抓取到本地的网页实际上是互联网内容的一个镜像与备份。互联网是动态变化的,当一部分互联网上的内容发生变化后,抓取到本地的网页就过期了。所以,已下载的网页分为已下载未过期网页和已下载已过期网页两类。

图 4 网页分类

待下载网页是指待抓取 URL 队列中的这些页面。

可知网页是指还没有抓取出来,也没有在待抓取 URL 队列中,但是可以通过对已抓取页面或则待抓取 URL 对应页面进行剖析,从而获取到的网页。

还有一部分网页,网络爬虫是难以直接抓取下载的,称为不可知网页。

下面重点介绍几种常见的抓取策略。1. 通用网路爬虫通用网路爬虫又称全网爬虫,爬行对象从一些种子 URL 扩展到整个 Web,主要为门户站点搜索引擎和小型 Web 服务提供商采集数据。

为提升工作效率,通用网路爬虫会采取一定的爬行策略。常用的爬行策略有深度优先策略和广度优先策略。

1)深度优先策略

深度优先策略是指网络爬虫会从起始页开始,一个链接一个链接地跟踪下去,直到不能再深入为止。

网络爬虫在完成一个爬行分支后返回到上一链接结点进一步搜索其他链接。当所有链接遍历完后,爬行任务结束。

这种策略比较适宜垂直搜索或站内搜索,但爬行页面内容层次较深的站点时会导致资源的巨大浪费。

以图 3 为例,遍历的路径为 1→2→5→6→3→7→4→8。

在深度优先策略中,当搜索到某一个结点的时侯,这个结点的子结点及该子结点的后继结点全部优先于该结点的兄弟结点,深度优先策略在搜索空间的时侯会尽量地往深处去,只有找不到某结点的后继结点时才考虑它的兄弟结点。

这样的策略就决定了深度优先策略不一定能找到最优解,并且因为深度的限制甚至找不到解。

如果不加限制,就会顺着一条路径无限制地扩充下去,这样才会“陷入”到巨大的数据量中。一般情况下,使用深度优先策略就会选择一个合适的深度,然后反复地搜索,直到找到解,这样搜索的效率就增加了。所以深度优先策略通常在搜索数据量比较小的时侯才使用。

2)广度优先策略

广度优先策略根据网页内容目录层次深浅来爬行页面,处于较浅目录层次的页面首先被爬行。当同一层次中的页面爬行完毕后,爬虫再深入下一层继续爬行。

仍然以图 3 为例,遍历的路径为 1→2→3→4→5→6→7→8

由于广度优先策略是对第 N 层的结点扩充完成后才步入第 N+1 层的,所以可以保证以最短路径找到解。

这种策略才能有效控制页面的爬行深度,避免碰到一个无穷深层分支时未能结束爬行的问题,实现便捷,无须储存大量中间结点,不足之处在于需较长时间能够爬行到目录层次较深的页面。

如果搜索时分支过多,也就是结点的后继结点太多,就会让算法用尽资源,在可以借助的空间內找不到解。2. 聚焦网路爬虫聚焦网路爬虫又称主题网路爬虫,是指选择性地爬行这些与预先定义好的主题相关的页面的网路爬虫。

1)基于内容评价的爬行策略

DeBra 将文本相似度的估算方式引入到网路爬虫中,提出了 Fish Search 算法。

该算法将用户输入的查询词作为主题,收录查询词的页面被视为与主题相关的页面,其局限性在于难以评价页面与主题相关度的大小。

Herseovic 对 Fish Search 算法进行了改进,提出了 Shark Search 算法,即借助空间向量模型估算页面与主题的相关度大小。

采用基于连续值估算链接价值的方式,不但可以估算出什么抓取的链接和主题相关,还可以得到相关度的量化大小。

2)基于链接结构评价的爬行策略

网页不同于通常文本,它是一种半结构化的文档,收录了许多结构化的信息。

网页不是单独存在的,页面中的链接指示了页面之间的互相关系,基于链接结构的搜索策略模式借助这种结构特点来评价页面和链接的重要性,以此决定搜索的次序。其中,PageRank 算法是这类搜索策略模式的代表。

PageRank 算法的基本原理是,如果一个网页多次被引用,则可能是很重要的网页,如果一个网页没有被多次引用,但是被重要的网页引用,也有可能是重要的网页。一个网页的重要性被平均地传递到它所引用的网页上。

将某个页面的 PageRank 除以存在于这个页面的正向链接,并将得到的值分别和正向链接所指的页面的 PageRank 相加,即得到了被链接的页面的 PageRank。

如图 5 所示,PageRank 值为 100 的网页把它的重要性平均传递给了它所引用的两个页面,每个页面获得了 50,同样 PageRank 值为 9 的网页给它所引用的 3 个页面的每位页面传递的值为 3。

PageRank 值为 53 的页面的值来源于两个引用了它的页面传递过来的值。

、

图 5 PageRank 算法示例

3)基于提高学习的爬行策略

Rennie 和 McCallum 将提高学习引入聚焦爬虫,利用贝叶斯分类器,根据整个网页文本和链接文本对超链接进行分类,为每位链接估算出重要性,从而决定链接的访问次序。

4)基于语境图的爬行策略

Diligenti 等人提出了一种通过构建语境图学习网页之间的相关度的爬行策略,该策略可训练一个机器学习系统,通过该系统可估算当前页面到相关 Web 页面的距离,距离逾的页面中的链接优先访问。3. 增量式网络爬虫增量式网络爬虫是指对已下载网页采取增量式更新而且只爬行新形成的或则已然发生变化网页的爬虫,它还能在一定程度上保证所爬行的页面是尽可能新的页面。

增量式网路爬虫有两个目标:

为实现第一个目标,增量式网路爬虫须要通过重新访问网页来更新本地页面集中页面的内容。常用的技巧有统一更新法、个体更新法和基于分类的更新法。

为实现第二个目标,增量式网路爬虫须要对网页的重要性排序,常用的策略有广度优先策略、PageRank 优先策略等。4. 深层网路爬虫网页按存在形式可以分为表层网页和深层网页。

深层网路爬虫体系结构收录 6 个基本功能模块(爬行控制器、解析器、表单分析器、表单处理器、响应分析器、LVS 控制器)和两个爬虫内部数据结构(URL 列表和 LVS 表)。

其中,LVS(LabelValueSet)表示标签和数值集合,用来表示填充表单的数据源。在爬取过程中,最重要的部份就是表单填写,收录基于领域知识的表单填写和基于网页结构剖析的表单填写两种。 查看全部

网络数据采集是指通过网路爬虫或网站公开 API 等方法从网站上获取数据信息。该方式可以将非结构化数据从网页中抽取下来,将其储存为统一的本地数据文件,并以结构化的形式储存。它支持图片、音频、视频等文件或附件的采集,附件与正文可以手动关联。

在互联网时代,网络爬虫主要是为搜索引擎提供最全面和最新的数据。

在大数据时代,网络爬虫更是从互联网上采集数据的有利工具。目前早已晓得的各类网路爬虫工具早已有上百个,网络爬虫工具基本可以分为 3 类。

本节首先对网路爬虫的原理和工作流程进行简单介绍,然后对网路爬虫抓取策略进行讨论,最后对典型的网路工具进行描述。网络爬虫原理网络爬虫是一种根据一定的规则,自动地抓取 Web 信息的程序或则脚本。

Web 网络爬虫可以手动采集所有其才能访问到的页面内容,为搜索引擎和大数据剖析提供数据来源。从功能上来讲,爬虫通常有数据采集、处理和储存 3 部分功能,如图 1 所示。

图 1 网络爬虫示意

网页中不仅收录供用户阅读的文字信息外,还收录一些超链接信息。

网络爬虫系统正是通过网页中的超链接信息不断获得网路上的其他网页的。网络爬虫从一个或若干初始网页的 URL 开始,获得初始网页上的 URL,在抓取网页的过程中,不断从当前页面上抽取新的 URL 放入队列,直到满足系统的一定停止条件。

网络爬虫系统通常会选择一些比较重要的、出度(网页中链出的超链接数)较大的网站的 URL 作为种子 URL 集合。

网络爬虫系统以这种种子集合作为初始 URL,开始数据的抓取。因为网页中富含链接信息,通过已有网页的 URL 会得到一些新的 URL。

可以把网页之间的指向结构视为一个森林,每个种子 URL 对应的网页是森林中的一棵树的根结点,这样网路爬虫系统就可以按照广度优先搜索算法或则深度优先搜索算法遍历所有的网页。

由于深度优先搜索算法可能会让爬虫系统深陷一个网站内部,不利于搜索比较紧靠网站首页的网页信息,因此通常采用广度优先搜索算法采集网页。

网络爬虫系统首先将种子 URL 放入下载队列,并简单地从队首取出一个 URL 下载其对应的网页,得到网页的内容并将其储存后,经过解析网页中的链接信息可以得到一些新的 URL。

其次,根据一定的网页分析算法过滤掉与主题无关的链接,保留有用的链接并将其倒入等待抓取的 URL 队列。

最后,取出一个 URL,对其对应的网页进行下载,然后再解析,如此反复进行,直到遍历了整个网路或则满足某种条件后才能停止出来。网络爬虫工作流程如图 2 所示,网络爬虫的基本工作流程如下。

1)首先选定一部分种子 URL。

2)将这种 URL 放入待抓取 URL 队列。

3)从待抓取 URL 队列中取出待抓取 URL,解析 DNS,得到主机的 IP 地址,并将 URL 对应的网页下载出来,存储到已下载网页库中。此外,将这种 URL 放进已抓取 URL 队列。

4)分析已抓取 URL 队列中的 URL,分析其中的其他 URL,并且将这种 URL 放入待抓取 URL 队列,从而步入下一个循环。

图 2网路爬虫的基本工作流程

网络爬虫抓取策略Google 和百度等通用搜索引擎抓取的网页数目一般都是以亿为单位估算的。那么,面对这么诸多的网页,通过何种方法能够让网络爬虫尽可能地遍历所有网页,从而尽可能地扩大网页信息的抓取覆盖面,这是网路爬虫系统面对的一个太关键的问题。在网路爬虫系统中,抓取策略决定了抓取网页的次序。

本节首先对网路爬虫抓取策略用到的基本概念做简单介绍。1)网页间关系模型从互联网的结构来看,网页之间通过数目不等的超链接互相联接,形成一个彼此关联、庞大复杂的有向图。

如图 3 所示,如果将网页看成是图中的某一个结点,而将网页中指向其他网页的链接看成是这个结点指向其他结点的边,那么我们很容易将整个互联网上的网页建模成一个有向图。

理论上讲,通过遍历算法遍历该图,可以访问到互联网上几乎所有的网页。

图 3网页关系模型图

2)网页分类从爬虫的角度对互联网进行界定,可以将互联网的所有页面分为 5 个部份:已下载未过期网页、已下载已过期网页、待下载网页、可知网页和不可知网页,如图 4 所示。

抓取到本地的网页实际上是互联网内容的一个镜像与备份。互联网是动态变化的,当一部分互联网上的内容发生变化后,抓取到本地的网页就过期了。所以,已下载的网页分为已下载未过期网页和已下载已过期网页两类。

图 4 网页分类

待下载网页是指待抓取 URL 队列中的这些页面。

可知网页是指还没有抓取出来,也没有在待抓取 URL 队列中,但是可以通过对已抓取页面或则待抓取 URL 对应页面进行剖析,从而获取到的网页。

还有一部分网页,网络爬虫是难以直接抓取下载的,称为不可知网页。

下面重点介绍几种常见的抓取策略。1. 通用网路爬虫通用网路爬虫又称全网爬虫,爬行对象从一些种子 URL 扩展到整个 Web,主要为门户站点搜索引擎和小型 Web 服务提供商采集数据。

为提升工作效率,通用网路爬虫会采取一定的爬行策略。常用的爬行策略有深度优先策略和广度优先策略。

1)深度优先策略

深度优先策略是指网络爬虫会从起始页开始,一个链接一个链接地跟踪下去,直到不能再深入为止。

网络爬虫在完成一个爬行分支后返回到上一链接结点进一步搜索其他链接。当所有链接遍历完后,爬行任务结束。

这种策略比较适宜垂直搜索或站内搜索,但爬行页面内容层次较深的站点时会导致资源的巨大浪费。

以图 3 为例,遍历的路径为 1→2→5→6→3→7→4→8。

在深度优先策略中,当搜索到某一个结点的时侯,这个结点的子结点及该子结点的后继结点全部优先于该结点的兄弟结点,深度优先策略在搜索空间的时侯会尽量地往深处去,只有找不到某结点的后继结点时才考虑它的兄弟结点。

这样的策略就决定了深度优先策略不一定能找到最优解,并且因为深度的限制甚至找不到解。

如果不加限制,就会顺着一条路径无限制地扩充下去,这样才会“陷入”到巨大的数据量中。一般情况下,使用深度优先策略就会选择一个合适的深度,然后反复地搜索,直到找到解,这样搜索的效率就增加了。所以深度优先策略通常在搜索数据量比较小的时侯才使用。

2)广度优先策略

广度优先策略根据网页内容目录层次深浅来爬行页面,处于较浅目录层次的页面首先被爬行。当同一层次中的页面爬行完毕后,爬虫再深入下一层继续爬行。

仍然以图 3 为例,遍历的路径为 1→2→3→4→5→6→7→8

由于广度优先策略是对第 N 层的结点扩充完成后才步入第 N+1 层的,所以可以保证以最短路径找到解。

这种策略才能有效控制页面的爬行深度,避免碰到一个无穷深层分支时未能结束爬行的问题,实现便捷,无须储存大量中间结点,不足之处在于需较长时间能够爬行到目录层次较深的页面。

如果搜索时分支过多,也就是结点的后继结点太多,就会让算法用尽资源,在可以借助的空间內找不到解。2. 聚焦网路爬虫聚焦网路爬虫又称主题网路爬虫,是指选择性地爬行这些与预先定义好的主题相关的页面的网路爬虫。

1)基于内容评价的爬行策略

DeBra 将文本相似度的估算方式引入到网路爬虫中,提出了 Fish Search 算法。

该算法将用户输入的查询词作为主题,收录查询词的页面被视为与主题相关的页面,其局限性在于难以评价页面与主题相关度的大小。

Herseovic 对 Fish Search 算法进行了改进,提出了 Shark Search 算法,即借助空间向量模型估算页面与主题的相关度大小。

采用基于连续值估算链接价值的方式,不但可以估算出什么抓取的链接和主题相关,还可以得到相关度的量化大小。

2)基于链接结构评价的爬行策略

网页不同于通常文本,它是一种半结构化的文档,收录了许多结构化的信息。

网页不是单独存在的,页面中的链接指示了页面之间的互相关系,基于链接结构的搜索策略模式借助这种结构特点来评价页面和链接的重要性,以此决定搜索的次序。其中,PageRank 算法是这类搜索策略模式的代表。

PageRank 算法的基本原理是,如果一个网页多次被引用,则可能是很重要的网页,如果一个网页没有被多次引用,但是被重要的网页引用,也有可能是重要的网页。一个网页的重要性被平均地传递到它所引用的网页上。

将某个页面的 PageRank 除以存在于这个页面的正向链接,并将得到的值分别和正向链接所指的页面的 PageRank 相加,即得到了被链接的页面的 PageRank。

如图 5 所示,PageRank 值为 100 的网页把它的重要性平均传递给了它所引用的两个页面,每个页面获得了 50,同样 PageRank 值为 9 的网页给它所引用的 3 个页面的每位页面传递的值为 3。

PageRank 值为 53 的页面的值来源于两个引用了它的页面传递过来的值。

、

图 5 PageRank 算法示例

3)基于提高学习的爬行策略

Rennie 和 McCallum 将提高学习引入聚焦爬虫,利用贝叶斯分类器,根据整个网页文本和链接文本对超链接进行分类,为每位链接估算出重要性,从而决定链接的访问次序。

4)基于语境图的爬行策略

Diligenti 等人提出了一种通过构建语境图学习网页之间的相关度的爬行策略,该策略可训练一个机器学习系统,通过该系统可估算当前页面到相关 Web 页面的距离,距离逾的页面中的链接优先访问。3. 增量式网络爬虫增量式网络爬虫是指对已下载网页采取增量式更新而且只爬行新形成的或则已然发生变化网页的爬虫,它还能在一定程度上保证所爬行的页面是尽可能新的页面。

增量式网路爬虫有两个目标:

为实现第一个目标,增量式网路爬虫须要通过重新访问网页来更新本地页面集中页面的内容。常用的技巧有统一更新法、个体更新法和基于分类的更新法。

为实现第二个目标,增量式网路爬虫须要对网页的重要性排序,常用的策略有广度优先策略、PageRank 优先策略等。4. 深层网路爬虫网页按存在形式可以分为表层网页和深层网页。

深层网路爬虫体系结构收录 6 个基本功能模块(爬行控制器、解析器、表单分析器、表单处理器、响应分析器、LVS 控制器)和两个爬虫内部数据结构(URL 列表和 LVS 表)。

其中,LVS(LabelValueSet)表示标签和数值集合,用来表示填充表单的数据源。在爬取过程中,最重要的部份就是表单填写,收录基于领域知识的表单填写和基于网页结构剖析的表单填写两种。

新疆会计人员信息采集常见问题解答

采集交流 • 优采云 发表了文章 • 0 个评论 • 278 次浏览 • 2020-08-10 20:45

新疆会计人员信息采集入口:

新疆会计人员信息采集常见问题解答

(建议使用360、谷歌Chrome、IE浏览器)

1.会计从业资格证与会计专业技术资格证区别是哪些呢?

答:会计从业资格证是一种资格证书,在2017年以前是从事会计工作必须具备的基本最低要求和前提条件,是步入会计岗位的“准入证”,不分级别。根据财政部有关规定,自2017年11月5日起会计从业资格证早已被取消,正式退出历史舞台。

会计专业技术资格,是指兼任会计专业职务的任职资格,是从事会计专业技术工作的必备条件,分中级,中级和中级三个级别。获得会计专业技术资格的途径是出席财政部、人事部共同组织的全省统一考试,并且成绩合格。

会计从业资格证书

会计专业技术资格证书

2.无法查看信息采集内容或则未能上传附件该如何办?

答:推荐使用Microsoft Internet Explorer 10.0 及以上版本或Google Chrome浏览器。如果您使用的是360浏览器,可在地址栏两侧,快速切换为急速模式(兼容模式图标;极速模式图标)。

3.我先前的继续教育记录找不到?

答:新版的继续教育模块还未即将启用,请在登陆后的主页上点击最右侧的“继续教育报考”可查看已完成的继续教育记录,也可以继续进行学习。

4. 问题:如何更改身份证号码。

答:学员难以自己更改身份证号码,必须携带身份证和大队证明到行政区划所在地的财政会计管理机构申请更改。

5. 问题:学员注册系统,提示身份证号已存在。

答:您已在老系统中注册过,如果早已注册过,用身份证号登录,默认密码是123456。

6.问题:学员登入系统后,做更改信息、上传附件、新增证书、新增学历等操作时,点击上传(或递交)无反应。

答:建议使用谷歌Chrome、360、ie10以上版本浏览器,其他浏览器存在不兼容问题。如果是360浏览器点击上传无反应,请切换浏览器模式为急速模式。切换方法如下:

7.问题:修改单位信息时,输入框为白色,无法输入。

答:修改单位时,应点击输入框旁的查询按键

进入检索界面,再输入单位信息,点击查询(支持模糊查询),检索到自己的单位后,点击选择,并且,修改完须要再度页面点击递交按键就能递交给管理员初审。

8. 问题:会员不知道自己所属的行政区划。

答:在个人中心,我的资料页面。

9. 问题:学员忘掉密码,无法登录系统。

答:在登入界面点击忘掉密码,直接用手机号寻回密码,如果手机号也忘掉,就找管理员重置密码。 查看全部

新疆会计人员信息采集常见问题解答

新疆会计人员信息采集入口:

新疆会计人员信息采集常见问题解答

(建议使用360、谷歌Chrome、IE浏览器)

1.会计从业资格证与会计专业技术资格证区别是哪些呢?

答:会计从业资格证是一种资格证书,在2017年以前是从事会计工作必须具备的基本最低要求和前提条件,是步入会计岗位的“准入证”,不分级别。根据财政部有关规定,自2017年11月5日起会计从业资格证早已被取消,正式退出历史舞台。

会计专业技术资格,是指兼任会计专业职务的任职资格,是从事会计专业技术工作的必备条件,分中级,中级和中级三个级别。获得会计专业技术资格的途径是出席财政部、人事部共同组织的全省统一考试,并且成绩合格。

会计从业资格证书

会计专业技术资格证书

2.无法查看信息采集内容或则未能上传附件该如何办?

答:推荐使用Microsoft Internet Explorer 10.0 及以上版本或Google Chrome浏览器。如果您使用的是360浏览器,可在地址栏两侧,快速切换为急速模式(兼容模式图标;极速模式图标)。

3.我先前的继续教育记录找不到?

答:新版的继续教育模块还未即将启用,请在登陆后的主页上点击最右侧的“继续教育报考”可查看已完成的继续教育记录,也可以继续进行学习。

4. 问题:如何更改身份证号码。

答:学员难以自己更改身份证号码,必须携带身份证和大队证明到行政区划所在地的财政会计管理机构申请更改。

5. 问题:学员注册系统,提示身份证号已存在。

答:您已在老系统中注册过,如果早已注册过,用身份证号登录,默认密码是123456。

6.问题:学员登入系统后,做更改信息、上传附件、新增证书、新增学历等操作时,点击上传(或递交)无反应。

答:建议使用谷歌Chrome、360、ie10以上版本浏览器,其他浏览器存在不兼容问题。如果是360浏览器点击上传无反应,请切换浏览器模式为急速模式。切换方法如下:

7.问题:修改单位信息时,输入框为白色,无法输入。

答:修改单位时,应点击输入框旁的查询按键

进入检索界面,再输入单位信息,点击查询(支持模糊查询),检索到自己的单位后,点击选择,并且,修改完须要再度页面点击递交按键就能递交给管理员初审。

8. 问题:会员不知道自己所属的行政区划。

答:在个人中心,我的资料页面。

9. 问题:学员忘掉密码,无法登录系统。

答:在登入界面点击忘掉密码,直接用手机号寻回密码,如果手机号也忘掉,就找管理员重置密码。

防止网站内容被采集的方式

采集交流 • 优采云 发表了文章 • 0 个评论 • 249 次浏览 • 2020-08-10 18:04

第三:更新网站内容后将URL递交给百度

之所以避免他人剽窃或采集,根本诱因还是害怕百度不再收录自己站点的内容,因此我们在更新网站后可以把文章URL直接递交给百度,ping一下没有益处,虽然百度不会马上收录那些URL,但是通过ping或外链吸引确实可以使百度蜘蛛赶快过来。当然也会涉及到小站上的优质内容,目的就是鼓励原创内容,打击采集或剽窃的现象,让原创内容最快的收录。不过目前看来原创星火计划还处于早期试验阶段,至少在小站上没有哪些好的彰显,本文介绍了三种途径或方式去防止内容被盗用,可惜的是没办法从根本起来解决这个问题,最后笔者只能说按照自己情况去选择吧。只希望百度才能在技术上有所提高,尽可能的使原创内容收录更快。

以上三点就是诺亚商舟对于防采集的一些观点,希望能给你们带来一些帮助。 查看全部

通常情况下,我们写完一篇原创文章都喜欢在末尾加上版权信息,可是这样的版权信息没有实际意义,别人既然选择了剽窃或采集,自然不会去管这些东西。而且文章末尾加链接或锚文本也不是一个好习惯,最好是在文章内容中自然出现关键词或锚文本链接,如果他人采集你网站上的内容就能带上链接,那样的话损失也不算大,也就是免费给你做外部链接了,关键是怎样隐藏好链接,避免被他人给删除,在文章结尾的地方加链接肯定一眼才能看见,所以我建议尽量在文章内容中加链接,另外还可以把锚文本的颜色设置跟普通文字的颜色一样,这样不容易被他人发觉,其实有很多的站长比较懒惰,有时候不会去检测的这么仔细。总之,这也是一种治标不治本的技巧。

第三:更新网站内容后将URL递交给百度

之所以避免他人剽窃或采集,根本诱因还是害怕百度不再收录自己站点的内容,因此我们在更新网站后可以把文章URL直接递交给百度,ping一下没有益处,虽然百度不会马上收录那些URL,但是通过ping或外链吸引确实可以使百度蜘蛛赶快过来。当然也会涉及到小站上的优质内容,目的就是鼓励原创内容,打击采集或剽窃的现象,让原创内容最快的收录。不过目前看来原创星火计划还处于早期试验阶段,至少在小站上没有哪些好的彰显,本文介绍了三种途径或方式去防止内容被盗用,可惜的是没办法从根本起来解决这个问题,最后笔者只能说按照自己情况去选择吧。只希望百度才能在技术上有所提高,尽可能的使原创内容收录更快。

以上三点就是诺亚商舟对于防采集的一些观点,希望能给你们带来一些帮助。

Python获取网页指定内容(BeautifulSoup工具的使用方式)

采集交流 • 优采云 发表了文章 • 0 个评论 • 232 次浏览 • 2020-08-10 14:19

1 Pyhton获取网页的内容(也就是源代码)

page = urllib2.urlopen(url)

contents = page.read()

#获得了整个网页的内容也就是源代码

print(contents)

url代表网址,contents代表网址所对应的源代码,urllib2是须要用到的包,以上三句代码才能获得网页的整个源代码

2 获取网页中想要的内容(先要获得网页源代码,再剖析网页源代码,找所对应的标签,然后提取出标签中的内容)

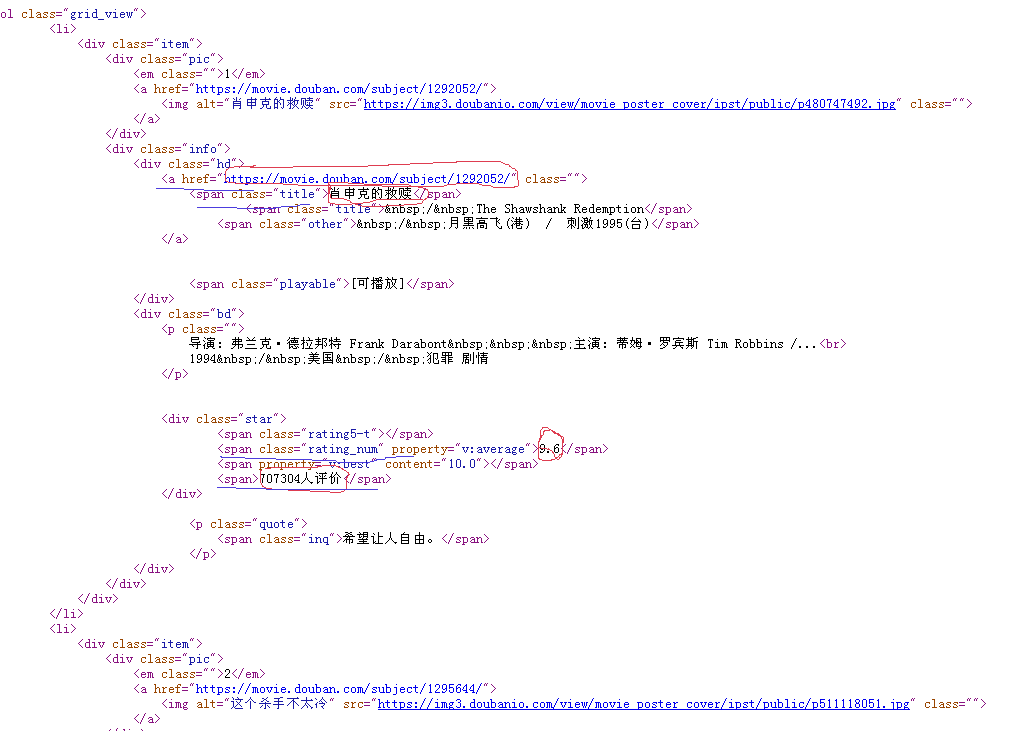

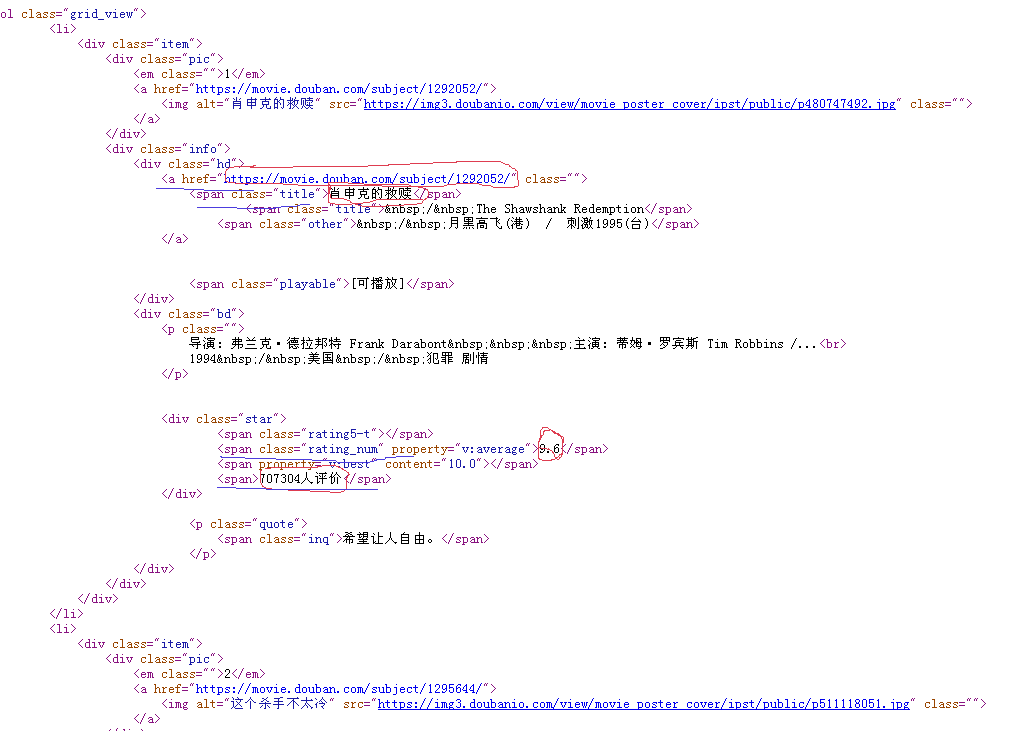

2.1 以豆瓣影片排行为反例

网址是,进入网址后就出现如下的图

现在我须要获得当前页面的所有影片的名子,评分,评价人数,链接

由上图画白色圆圈的是我想得到的内容,画黄色横线的为所对应的标签,这样就剖析完了,现在就是写代码实现,Python提供了好多种方式去获得想要的内容,在此我使用BeautifulSoup来实现,非常的简单

#coding:utf-8

'''''

@author: jsjxy

'''

import urllib2

import re

from bs4 import BeautifulSoup

from distutils.filelist import findall

page = urllib2.urlopen('http://movie.douban.com/top250?format=text')

contents = page.read()

#print(contents)

soup = BeautifulSoup(contents,"html.parser")

print("豆瓣电影TOP250" + "\n" +" 影片名 评分 评价人数 链接 ")

for tag in soup.find_all('div', class_='info'):

# print tag

m_name = tag.find('span', class_='title').get_text()

m_rating_score = float(tag.find('span',class_='rating_num').get_text())

m_people = tag.find('div',class_="star")

m_span = m_people.findAll('span')

m_peoplecount = m_span[3].contents[0]

m_url=tag.find('a').get('href')

print( m_name+" " + str(m_rating_score) + " " + m_peoplecount + " " + m_url )

控制台输出,你也可以写入文件中 查看全部

Python用做数据处理还是相当不错的,如果你想要做爬虫,Python是挺好的选择,它有很多早已写好的类包,只要调用,即可完成好多复杂的功能,此文中所有的功能都是基于BeautifulSoup这个包。

1 Pyhton获取网页的内容(也就是源代码)

page = urllib2.urlopen(url)

contents = page.read()

#获得了整个网页的内容也就是源代码

print(contents)

url代表网址,contents代表网址所对应的源代码,urllib2是须要用到的包,以上三句代码才能获得网页的整个源代码

2 获取网页中想要的内容(先要获得网页源代码,再剖析网页源代码,找所对应的标签,然后提取出标签中的内容)

2.1 以豆瓣影片排行为反例

网址是,进入网址后就出现如下的图

现在我须要获得当前页面的所有影片的名子,评分,评价人数,链接

由上图画白色圆圈的是我想得到的内容,画黄色横线的为所对应的标签,这样就剖析完了,现在就是写代码实现,Python提供了好多种方式去获得想要的内容,在此我使用BeautifulSoup来实现,非常的简单

#coding:utf-8

'''''

@author: jsjxy

'''

import urllib2

import re

from bs4 import BeautifulSoup

from distutils.filelist import findall

page = urllib2.urlopen('http://movie.douban.com/top250?format=text')

contents = page.read()

#print(contents)

soup = BeautifulSoup(contents,"html.parser")

print("豆瓣电影TOP250" + "\n" +" 影片名 评分 评价人数 链接 ")

for tag in soup.find_all('div', class_='info'):

# print tag

m_name = tag.find('span', class_='title').get_text()

m_rating_score = float(tag.find('span',class_='rating_num').get_text())

m_people = tag.find('div',class_="star")

m_span = m_people.findAll('span')

m_peoplecount = m_span[3].contents[0]

m_url=tag.find('a').get('href')

print( m_name+" " + str(m_rating_score) + " " + m_peoplecount + " " + m_url )

控制台输出,你也可以写入文件中

熊掌号:SEO重复内容与采集站, 会被惩罚吗

采集交流 • 优采云 发表了文章 • 0 个评论 • 265 次浏览 • 2020-08-09 13:00

1、百度究竟是否会惩罚重复内容

这里首先须要明晰的是重复内容与采集站点,还是有一定区别的,目前来讲,百度对于重复内容并没有显著的严打征兆,也可以如此理解,百度对重复内容是不会惩罚的。

虽然这么好多SEO专家,在做网站诊断的时侯还会讨论外部站点重复内容的数目问题,正常来讲会通过站长工具来统计是否被附送原文链接!

这里你们始终苦恼的问题:文章被转发后,排名比自己的高,百度太明晰仍然在企图解决这个问题,但仍在测试阶段,这点我们可以在近来推出的熊掌号看出希望,有权限的站长,可以在熊掌号下的原创保护递交原创内容,其中太非常一点就是文章发布的时间须要精确到秒:

这是一个太明晰的讯号,拥有原创保护的站点,提交链接一旦初审通过,在移动端的搜索诠释上都会加注原创标签,排名自然都会比转发文章高。

2、采集内容排行为何这么高

这上面的采集内容,应该是一分为二的,主要有下边两种情况:

权威站点转发

整站采集

权威站点转发,在百度推出熊掌号后,会得到显著的改善,那么百度为何给与这部份站点的转发内容很高的排行,这与站点权威度以及原创比列有一定关系,同时为了更好的把优质文章展现今搜索结果页面,从信息传播的角度也是可以理解的,并且权威站点的转发,都会附送版权链接,给新站也是完善友好的外部链接。

整站采集就完全不同了,大批量的采集内容,虽然会保持网站有持续更新的频度,同时也会发觉收录还不错,但采集内容几乎没有排行,这也是目前新闻外链能够存活的一点点理由!

在百度推出飓风算法后,很明晰的心态就是严厉严打恶劣采集站点,看来日后连收录就会成为泡影。

3、内部重复内容是否会被惩罚

对于这个问题目前百度抒发的相对模糊,在近来推出的清风算法中,百度指出不要过多的优化标题,以关键词堆积等方式提升排行,言外之意,标题不要过分重复。

早前也有部份SEO专家表明:

利用反义词或是变相的关键词作为标题制造多个页面,来覆盖关键词目前来讲是不被倡导的,尽量精简到一篇文章中,比如:

大豆的功效与作用

大豆的营养价值

这两个标题,在多个小吃网站你会看见就会有独立的页面存在,但就其内容而言,答案几乎太相仿,百度会希望你们把这两个问题融合在一起,比如:大豆的营养价值,它的功效与作用有什么?

总结:SEO是一种策略,特别是面对重复内容与采集内容的时侯,有的时侯很难判定,很多站长走在临界点 查看全部

重复内容是SEO行业仍然关注的问题,重复内容究竟会不会被搜索引擎惩罚,这是一个被常常讨论的话题,百度近来对内容采集站点进行大批量的降权,但仍有太同事发觉自己的文章被转载,排名仍然比自己的原创高,那么互联网上这么多的重复内容,百度是怎样对待的呢?

1、百度究竟是否会惩罚重复内容

这里首先须要明晰的是重复内容与采集站点,还是有一定区别的,目前来讲,百度对于重复内容并没有显著的严打征兆,也可以如此理解,百度对重复内容是不会惩罚的。

虽然这么好多SEO专家,在做网站诊断的时侯还会讨论外部站点重复内容的数目问题,正常来讲会通过站长工具来统计是否被附送原文链接!

这里你们始终苦恼的问题:文章被转发后,排名比自己的高,百度太明晰仍然在企图解决这个问题,但仍在测试阶段,这点我们可以在近来推出的熊掌号看出希望,有权限的站长,可以在熊掌号下的原创保护递交原创内容,其中太非常一点就是文章发布的时间须要精确到秒:

这是一个太明晰的讯号,拥有原创保护的站点,提交链接一旦初审通过,在移动端的搜索诠释上都会加注原创标签,排名自然都会比转发文章高。

2、采集内容排行为何这么高

这上面的采集内容,应该是一分为二的,主要有下边两种情况:

权威站点转发

整站采集

权威站点转发,在百度推出熊掌号后,会得到显著的改善,那么百度为何给与这部份站点的转发内容很高的排行,这与站点权威度以及原创比列有一定关系,同时为了更好的把优质文章展现今搜索结果页面,从信息传播的角度也是可以理解的,并且权威站点的转发,都会附送版权链接,给新站也是完善友好的外部链接。

整站采集就完全不同了,大批量的采集内容,虽然会保持网站有持续更新的频度,同时也会发觉收录还不错,但采集内容几乎没有排行,这也是目前新闻外链能够存活的一点点理由!

在百度推出飓风算法后,很明晰的心态就是严厉严打恶劣采集站点,看来日后连收录就会成为泡影。

3、内部重复内容是否会被惩罚

对于这个问题目前百度抒发的相对模糊,在近来推出的清风算法中,百度指出不要过多的优化标题,以关键词堆积等方式提升排行,言外之意,标题不要过分重复。

早前也有部份SEO专家表明:

利用反义词或是变相的关键词作为标题制造多个页面,来覆盖关键词目前来讲是不被倡导的,尽量精简到一篇文章中,比如:

大豆的功效与作用

大豆的营养价值

这两个标题,在多个小吃网站你会看见就会有独立的页面存在,但就其内容而言,答案几乎太相仿,百度会希望你们把这两个问题融合在一起,比如:大豆的营养价值,它的功效与作用有什么?

总结:SEO是一种策略,特别是面对重复内容与采集内容的时侯,有的时侯很难判定,很多站长走在临界点

网站优化应如何正确使用采集到的内容?

采集交流 • 优采云 发表了文章 • 0 个评论 • 276 次浏览 • 2020-08-09 07:42

但是,搜索引擎强调内容的采集对网站意义不大,尤其是对于优化而言,甚至采集的内容也将被视为垃圾邮件,从而给网站造成负担. 实际上,即使采集的内容对网站没有影响,也可以. 但是,只要采集合理,它仍然有用,并且可以减少网站站长的原创烦恼并获得相同的优化效果. 那么,如何正确使用采集到的内容?

首先,内容的对象精美. 最好找到刚刚由其他人发布的内容作为采集目标,并在太多人重新发布之前采集它,但是内容的前提是它是前进的,新鲜的和有代表性的,而不是某些内容. 老式主题,否则将针对用户. 铜爵蜡的味道就不值一提了. 由于采集了内容,因此自然比原创内容要简单得多,因此您无需花费太多时间来编辑内容. 此时不要节省时间. 毕竟,采集的内容没有原创效果. 这很简单,因此您需要同时查找更多内容,以弥补蜘蛛的空虚.

第二,采集内容不采集标题. 每个人都知道,阅读文章时首先要看的是标题. 对于经过网站优化的搜索引擎,标题也具有一定的重要性. 采集的内容具有一定的长度,不能过多地更改,但是标题仅短短几个字,并且相对容易修改. 因此,标题的修改是必要的,最好将标题更改为原创标题. 原因很简单. 当您看到标题相同但实质完全不同的文章时,读者会误解两者的内容是相同的. 相反,即使内容相同,标题也完全不同. 这种新鲜感不容易被发现.

最后,对内容进行适当的调整. 尝试在自己的网站上采集内容的网站管理员肯定会发现直接复制的内容存在格式问题,因为一些聪明的原创创作者通常会向内容添加一些隐藏的内容,以防止采集内容. 格式,甚至版权都将标记在图片的ALT信息中. 如果您不注意,搜索引擎自然会将其识别为窃,对网站的危害是不言而喻的. 因此,必须对采集的内容进行格式化,并且必须转换英语格式的标点符号. 另外,可以将一些图片添加到内容中以使内容更丰富. 如果内容本身具有图片,则不要直接复制,最好是,另外,保存并上传到网站以及您自己的ALT信息,可以使采集到的内容更有价值.

简而言之,网站采集的内容并非完全无用. 关键取决于您如何采集它. 只要您可以灵活地使用采集的内容,就可以为网站带来一定的好处. 但是,网站管理员需要注意. 是的,必须掌握某些采集方法. 查看全部

在网站优化圈子中,网站管理员知道搜索引擎重视原创内容,但是无论SEOer面对长期的内容创建多么出色,都存在一定的困难. 不仅资源有限,而且书写能力也受到限制. 因此,整个网站,包括每个部分的内容,都无法避免被采集.

但是,搜索引擎强调内容的采集对网站意义不大,尤其是对于优化而言,甚至采集的内容也将被视为垃圾邮件,从而给网站造成负担. 实际上,即使采集的内容对网站没有影响,也可以. 但是,只要采集合理,它仍然有用,并且可以减少网站站长的原创烦恼并获得相同的优化效果. 那么,如何正确使用采集到的内容?

首先,内容的对象精美. 最好找到刚刚由其他人发布的内容作为采集目标,并在太多人重新发布之前采集它,但是内容的前提是它是前进的,新鲜的和有代表性的,而不是某些内容. 老式主题,否则将针对用户. 铜爵蜡的味道就不值一提了. 由于采集了内容,因此自然比原创内容要简单得多,因此您无需花费太多时间来编辑内容. 此时不要节省时间. 毕竟,采集的内容没有原创效果. 这很简单,因此您需要同时查找更多内容,以弥补蜘蛛的空虚.

第二,采集内容不采集标题. 每个人都知道,阅读文章时首先要看的是标题. 对于经过网站优化的搜索引擎,标题也具有一定的重要性. 采集的内容具有一定的长度,不能过多地更改,但是标题仅短短几个字,并且相对容易修改. 因此,标题的修改是必要的,最好将标题更改为原创标题. 原因很简单. 当您看到标题相同但实质完全不同的文章时,读者会误解两者的内容是相同的. 相反,即使内容相同,标题也完全不同. 这种新鲜感不容易被发现.

最后,对内容进行适当的调整. 尝试在自己的网站上采集内容的网站管理员肯定会发现直接复制的内容存在格式问题,因为一些聪明的原创创作者通常会向内容添加一些隐藏的内容,以防止采集内容. 格式,甚至版权都将标记在图片的ALT信息中. 如果您不注意,搜索引擎自然会将其识别为窃,对网站的危害是不言而喻的. 因此,必须对采集的内容进行格式化,并且必须转换英语格式的标点符号. 另外,可以将一些图片添加到内容中以使内容更丰富. 如果内容本身具有图片,则不要直接复制,最好是,另外,保存并上传到网站以及您自己的ALT信息,可以使采集到的内容更有价值.

简而言之,网站采集的内容并非完全无用. 关键取决于您如何采集它. 只要您可以灵活地使用采集的内容,就可以为网站带来一定的好处. 但是,网站管理员需要注意. 是的,必须掌握某些采集方法.

Afeng: SEO如何处理采集的内容(中间)-SEO基础知识

采集交流 • 优采云 发表了文章 • 0 个评论 • 366 次浏览 • 2020-08-09 07:19

这里忽略元数据的处理,因为元数据主要是为了添加逻辑映射. 例如,在公司黄页的网站上,我获取了诸如“ XXX公司规模,商标,年营业额和法人信息”之类的元数据. 我需要将这些元数据与该站点的数据库中的相应公司相关联. 因为元数据是短文本,所以它会立即被拾取,因此无需处理重复性.

如果采集的内容是长文本的大连续段落,则为确保SEO效果,在处理html源代码之后,也可以处理文本.

文本信息处理,包括标题和正文两部分(不考虑人工修改,仅考虑批处理)

标题

让我说,SEO的最重要和核心点是“单词”. 其他SEO技术和技术都基于“选择正确的词”以达到良好的效果.

最终目的是使用户可以搜索的单词出现在标题中. 详细信息页面标题中的单词应该具有少量搜索量,而百度搜索结果应该很少,而不是热门单词,每个人都在争先恐后地使用它.

首先,出现在网页标题中的关键字越多,被收录的可能性就越低. 这是肯定的,所以不要在58个Ganji这些大型网站上发表任何言论. 除非其重量很大,否则采集站将紧随其后. 否则,它基本上是没有用的.

第二,在垂直行业和充满个性化搜索内容的领域中,可以挖出很多竞争少,流量大的单词. 在垂直领域中很难找到这些单词,因为它需要了解行业,而且不仅仅使用SEO工具也很难找到.

个性化的搜索内容字段(例如程序开发,娱乐八卦等)始终充满个性化的搜索词,并且随着时间的流逝将不断产生新的搜索行为. 只要搜索引擎还没有结束,该领域就始终充满搜索流量,因此仔细观察后发现,这里有许多热闹而漫长的流量站点. 大多数内容选择都符合此功能. 与“招聘和二手车”等行业不同,用户的搜索行为基本上没有变化. ,几个电台全都抓取同一批单词,而且它们都已饱和,因此流量自然很困难.

如何在集合标题中插入搜索词

如果目标网站的标题与SEO不一致,例如抓住一堆新闻标题,那么标题如何集中于用户可能搜索的单词?我以前尝试过这些方法:

方法1: 简化原创标题

步骤如下:

对原创标题进行分区

删除停用词

添加词性

删除修饰词,例如形容词,副词,介词...,保留原创标题的主语-谓语-宾语,并获得句子的主语

基于python的jieba模块的实现,可以通过预先分析大量标题来提取要删除的修饰符,并将其附加到字典中. Github有现成的轮子,可以提取句子的主干,例如nltk.

1688年产品页面的部分标题似乎是这样制作的. 删除用户发布的产品名称中的一些不相关的词缀,并提取主词干并放置在标题标签中.

方法2: 插入搜索字词

步骤如下:

构建xunsearch或其他开源搜索,并为采集的标题建立索引

使用搜索项(即要完成的搜索项)在搜索界面中依次搜索.

在搜索结果中出现的标题之前插入当前搜索词

例如,原创标题是: “ Betta Beauty Anchor Live Sleeping Over 200,000” ...,我要输入的单词是“ Betta Beauty Live”,然后在标题之前插入关键字: “ [Betta Beauty Live ] Betta美女主播现场直播过夜20万元”

当然也可以: “ {强制搜索词} {简化的原创标题}”

方法3: 在当前标题中插入派生词和相关搜索词,其中已经收录搜索词

步骤如下:

利用标题已收录搜索词的相关百度搜索或下拉框,或使用Word2vec算法分析其他已爬网内容的主体,以获取搜索词的同义词.

在标题中插入相关的搜索或下拉单词

<p>例如: “ [[百度相关搜索字词1}] {简明标题}”,“ [{下拉框推荐字词1} {原标题}]” ...彼此组合... 查看全部

处理原创采集内容的文本信息

这里忽略元数据的处理,因为元数据主要是为了添加逻辑映射. 例如,在公司黄页的网站上,我获取了诸如“ XXX公司规模,商标,年营业额和法人信息”之类的元数据. 我需要将这些元数据与该站点的数据库中的相应公司相关联. 因为元数据是短文本,所以它会立即被拾取,因此无需处理重复性.

如果采集的内容是长文本的大连续段落,则为确保SEO效果,在处理html源代码之后,也可以处理文本.

文本信息处理,包括标题和正文两部分(不考虑人工修改,仅考虑批处理)

标题

让我说,SEO的最重要和核心点是“单词”. 其他SEO技术和技术都基于“选择正确的词”以达到良好的效果.

最终目的是使用户可以搜索的单词出现在标题中. 详细信息页面标题中的单词应该具有少量搜索量,而百度搜索结果应该很少,而不是热门单词,每个人都在争先恐后地使用它.

首先,出现在网页标题中的关键字越多,被收录的可能性就越低. 这是肯定的,所以不要在58个Ganji这些大型网站上发表任何言论. 除非其重量很大,否则采集站将紧随其后. 否则,它基本上是没有用的.

第二,在垂直行业和充满个性化搜索内容的领域中,可以挖出很多竞争少,流量大的单词. 在垂直领域中很难找到这些单词,因为它需要了解行业,而且不仅仅使用SEO工具也很难找到.

个性化的搜索内容字段(例如程序开发,娱乐八卦等)始终充满个性化的搜索词,并且随着时间的流逝将不断产生新的搜索行为. 只要搜索引擎还没有结束,该领域就始终充满搜索流量,因此仔细观察后发现,这里有许多热闹而漫长的流量站点. 大多数内容选择都符合此功能. 与“招聘和二手车”等行业不同,用户的搜索行为基本上没有变化. ,几个电台全都抓取同一批单词,而且它们都已饱和,因此流量自然很困难.

如何在集合标题中插入搜索词

如果目标网站的标题与SEO不一致,例如抓住一堆新闻标题,那么标题如何集中于用户可能搜索的单词?我以前尝试过这些方法:

方法1: 简化原创标题

步骤如下:

对原创标题进行分区

删除停用词

添加词性

删除修饰词,例如形容词,副词,介词...,保留原创标题的主语-谓语-宾语,并获得句子的主语

基于python的jieba模块的实现,可以通过预先分析大量标题来提取要删除的修饰符,并将其附加到字典中. Github有现成的轮子,可以提取句子的主干,例如nltk.

1688年产品页面的部分标题似乎是这样制作的. 删除用户发布的产品名称中的一些不相关的词缀,并提取主词干并放置在标题标签中.

方法2: 插入搜索字词

步骤如下:

构建xunsearch或其他开源搜索,并为采集的标题建立索引

使用搜索项(即要完成的搜索项)在搜索界面中依次搜索.

在搜索结果中出现的标题之前插入当前搜索词

例如,原创标题是: “ Betta Beauty Anchor Live Sleeping Over 200,000” ...,我要输入的单词是“ Betta Beauty Live”,然后在标题之前插入关键字: “ [Betta Beauty Live ] Betta美女主播现场直播过夜20万元”

当然也可以: “ {强制搜索词} {简化的原创标题}”

方法3: 在当前标题中插入派生词和相关搜索词,其中已经收录搜索词

步骤如下:

利用标题已收录搜索词的相关百度搜索或下拉框,或使用Word2vec算法分析其他已爬网内容的主体,以获取搜索词的同义词.

在标题中插入相关的搜索或下拉单词

<p>例如: “ [[百度相关搜索字词1}] {简明标题}”,“ [{下拉框推荐字词1} {原标题}]” ...彼此组合...

Python模拟采集器搜寻网页内容并采集网页

采集交流 • 优采云 发表了文章 • 0 个评论 • 353 次浏览 • 2020-08-09 05:41

1. 首先安装Python环境,作者是Python 2.7.8

2. 重新安装PIP或easy_install

3. 通过命令pip install selenium安装selenium,这是一个用于自动测试和爬网的工具

4. 然后在代码中修改用户名和密码,填写您自己的用户名和密码

5. 运行该程序并自动调用Firefox浏览器以登录到微博

注意: 移动终端上的信息更加精致和简单,并且对动态加载没有任何限制. 但是,如果微博或粉丝ID仅显示20页,这是它的缺点;尽管客户端可能具有动态加载功能,例如评论和微博,但其信息更加完整.

注意:

输入:

名人用户ID列表,使用URL +用户ID进行访问(这些ID可以从用户的监视列表中获得)

SinaWeibo_List_best_1.txt

输出:

微博信息和基本用户信息

SinaWeibo_Info_best_1.txt

Megry_Result_Best.py

此文件的用户组织特定日期(例如2018年4月23日)的用户微博信息 查看全部

python爬虫模拟抓取网页内容,采集网页内容,这里主要模拟新浪微博的内容,包括[源代码]抓取客户端微博信息,[源代码]抓取移动终端信息注意id和fan id(速度慢),[源代码]爬行移动终端的微博信息(强制推送)以及许多其他示例. 有关运行此示例的一些注意事项:

1. 首先安装Python环境,作者是Python 2.7.8

2. 重新安装PIP或easy_install

3. 通过命令pip install selenium安装selenium,这是一个用于自动测试和爬网的工具

4. 然后在代码中修改用户名和密码,填写您自己的用户名和密码

5. 运行该程序并自动调用Firefox浏览器以登录到微博

注意: 移动终端上的信息更加精致和简单,并且对动态加载没有任何限制. 但是,如果微博或粉丝ID仅显示20页,这是它的缺点;尽管客户端可能具有动态加载功能,例如评论和微博,但其信息更加完整.

注意:

输入:

名人用户ID列表,使用URL +用户ID进行访问(这些ID可以从用户的监视列表中获得)

SinaWeibo_List_best_1.txt

输出:

微博信息和基本用户信息

SinaWeibo_Info_best_1.txt

Megry_Result_Best.py

此文件的用户组织特定日期(例如2018年4月23日)的用户微博信息

如何为需要大量内容的网站填充网站内容

采集交流 • 优采云 发表了文章 • 0 个评论 • 181 次浏览 • 2020-08-09 05:08

采集到的内容物的比例最好保持在20%左右. 实际上,采集也有一定的好处. 首先,它丰富了网站的内容. 其次,如果您采集的内容首先由百度提供,那么百度当前的技术将认为您的文章是原创的. 因此,如何控制集合数,在这里我建议手动采集资源. 如果使用自动采集,则无法控制内容的相关性,并且删除不舒服的内容将花费更多时间,因此建议手动采集. 当然,该集合的内容不应过多,应该占总内容的20%.

另一个是我们可以为伪原创内容使用30%的比率. 由于没有太多创意,我们还应该使用伪原创来丰富网站本身的内容. 当然,我在这里谈论的伪原创并不是要颠倒文章的段落. 这些文章不可读,更多内容可能会损害网站本身. 我在这里谈论的是确保内容本身仍然可读. 您可以选择使用自己的单词来更改标题,总结内容或替换某些同义词. 但是最初的目的是确保内容的可读性. 在这里,我的伪原创内容约占网站内容的30%.

最重要的是网站的原创内容. 我们最好以50%的比例发布它. 在当今垃圾堆拥挤的Internet世界中,原创事物越来越少. 对于用户而言,无论您是原创用户还是非原创用户,只要内容可读即可. 但是搜索引擎也是我们的读者. 它具有区分原创和非原创的技术. 尽管当前的百度技术还不够,但是搜索引擎正在改进. 在这里,我正在做网站内容. 首先在您自己的网站上发布一些原创文章,然后在您设置的一个或两个关键字上放置一个内部链接,然后再次加粗文章内容中遇到的前两个关键字. 当然,让我们看一下页面的框架布局. 至于每个人的原创内容,网站的原创内容约占总内容的50%.

通过这种方式,我们可以有效地解决网站内容的问题,同时不会对网站的质量产生很大的影响. 查看全部

如何构建大型网站的内容?我们需要知道,原创文章会花费我们很多经验和时间. 作为一个大型网站,仅依靠原创内容绝对是不够的,因为它根本无法填充. 因此,我们不能使用前面提到的纯粹的原创方法,而应该合理地使用各种方法并在我们的网站中填充更多的内容,因此如何合理地分发是一个非常重要的问题.

采集到的内容物的比例最好保持在20%左右. 实际上,采集也有一定的好处. 首先,它丰富了网站的内容. 其次,如果您采集的内容首先由百度提供,那么百度当前的技术将认为您的文章是原创的. 因此,如何控制集合数,在这里我建议手动采集资源. 如果使用自动采集,则无法控制内容的相关性,并且删除不舒服的内容将花费更多时间,因此建议手动采集. 当然,该集合的内容不应过多,应该占总内容的20%.

另一个是我们可以为伪原创内容使用30%的比率. 由于没有太多创意,我们还应该使用伪原创来丰富网站本身的内容. 当然,我在这里谈论的伪原创并不是要颠倒文章的段落. 这些文章不可读,更多内容可能会损害网站本身. 我在这里谈论的是确保内容本身仍然可读. 您可以选择使用自己的单词来更改标题,总结内容或替换某些同义词. 但是最初的目的是确保内容的可读性. 在这里,我的伪原创内容约占网站内容的30%.

最重要的是网站的原创内容. 我们最好以50%的比例发布它. 在当今垃圾堆拥挤的Internet世界中,原创事物越来越少. 对于用户而言,无论您是原创用户还是非原创用户,只要内容可读即可. 但是搜索引擎也是我们的读者. 它具有区分原创和非原创的技术. 尽管当前的百度技术还不够,但是搜索引擎正在改进. 在这里,我正在做网站内容. 首先在您自己的网站上发布一些原创文章,然后在您设置的一个或两个关键字上放置一个内部链接,然后再次加粗文章内容中遇到的前两个关键字. 当然,让我们看一下页面的框架布局. 至于每个人的原创内容,网站的原创内容约占总内容的50%.

通过这种方式,我们可以有效地解决网站内容的问题,同时不会对网站的质量产生很大的影响.

熊掌: SEO的内容和采集网站重复,您会受到惩罚吗?答案就在这里!

采集交流 • 优采云 发表了文章 • 0 个评论 • 452 次浏览 • 2020-08-08 16:58

1. 百度会惩罚重复的内容吗?

首先要弄清楚的是,重复内容和采集网站之间存在一定差异. 目前,百度没有明显的打击重复内容的迹象. 也可以理解,百度不会惩罚重复的内容.

尽管有很多SEO专家,但在进行网站诊断时,他们将讨论外部网站上重复内容的数量. 通常,他们将使用网站站长工具来计算原创链接是否已附加!

这是每个人都在苦苦挣扎的问题: 转发文章后,排名高于自己的排名. 百度显然已经在尝试解决这个问题,但它仍处于测试阶段. 我们可以在最近推出的Bear Paw中看到这一点,我希望授权的网站管理员可以在Bear's Paw帐户的原创保护下提交原创内容. 其中一项特别之处在于,文章发表的时间必须精确到第二次:

这是一个非常清晰的信号. 对于具有原创保护的网站,一旦提交的链接获得批准,原创标签将被添加到移动终端的搜索显示中,排名自然会高于转发的文章.

2. 为什么采集的内容的排名如此之高?

此处采集的内容应分为两种,主要是在以下两种情况下:

权威的网站转发

整个网站集

百度发布“熊掌”后,权威性网站转发将得到显着改善. 那么,为什么百度为这些网站提供较高的转发内容排名呢?这与网站的权限和原创性的比例有一定关系. 从信息传播的角度来看,更好地在搜索结果页面上显示高质量的文章是可以理解的,并且在重新发布权威网站时将附带版权链接,并且还将为新网站建立友好的外部链接.

整个网站的集合完全不同. 内容的大规模采集将保持网站上连续更新的频率,并发现采集还不错,但是采集的内容几乎没有排名. 这也是当前新闻. 生存的一点理由!

百度发布了飓风算法后,很明显它将严厉打击严酷的采集站点.

3. 内部重复内容会受到惩罚吗?

对于此问题,百度目前的表述相对模糊. 在最近发布的“庆丰”算法中,百度强调不要过多地优化标题,并以关键字积累的形式增加排名. 含义是标题不应太重复.

一些SEO专家之前说过:

目前不提倡使用同义词或伪装关键字作为标题来创建多个页面来覆盖关键字. 尝试将其尽可能地精简为一篇文章,例如:

大豆的功效和功能

大豆的营养价值

通过这两个标题,您将看到多个食品网站上会有单独的页面,但是就其内容而言,答案几乎是相似的. 百度希望大家将这两个问题结合起来,例如: 大豆的营养价值,作用和功能是什么?

摘要: SEO是一种策略,尤其是当涉及重复内容和采集的内容时. 有时很难判断. 许多网站管理员正处在临界点. 如果您对重复的内容还有其他疑问,欢迎发表评论! 查看全部

重复内容是SEO业界一直关注的问题. 搜索引擎会惩罚重复的内容吗?这是一个经常讨论的话题. 百度最近大量减少了内容采集网站的权利,但仍有很多我的朋友发现他的文章被转载,排名仍然高于其原著. 那么百度如何处理互联网上如此众多的重复内容?

1. 百度会惩罚重复的内容吗?

首先要弄清楚的是,重复内容和采集网站之间存在一定差异. 目前,百度没有明显的打击重复内容的迹象. 也可以理解,百度不会惩罚重复的内容.

尽管有很多SEO专家,但在进行网站诊断时,他们将讨论外部网站上重复内容的数量. 通常,他们将使用网站站长工具来计算原创链接是否已附加!

这是每个人都在苦苦挣扎的问题: 转发文章后,排名高于自己的排名. 百度显然已经在尝试解决这个问题,但它仍处于测试阶段. 我们可以在最近推出的Bear Paw中看到这一点,我希望授权的网站管理员可以在Bear's Paw帐户的原创保护下提交原创内容. 其中一项特别之处在于,文章发表的时间必须精确到第二次:

这是一个非常清晰的信号. 对于具有原创保护的网站,一旦提交的链接获得批准,原创标签将被添加到移动终端的搜索显示中,排名自然会高于转发的文章.

2. 为什么采集的内容的排名如此之高?

此处采集的内容应分为两种,主要是在以下两种情况下:

权威的网站转发

整个网站集

百度发布“熊掌”后,权威性网站转发将得到显着改善. 那么,为什么百度为这些网站提供较高的转发内容排名呢?这与网站的权限和原创性的比例有一定关系. 从信息传播的角度来看,更好地在搜索结果页面上显示高质量的文章是可以理解的,并且在重新发布权威网站时将附带版权链接,并且还将为新网站建立友好的外部链接.

整个网站的集合完全不同. 内容的大规模采集将保持网站上连续更新的频率,并发现采集还不错,但是采集的内容几乎没有排名. 这也是当前新闻. 生存的一点理由!

百度发布了飓风算法后,很明显它将严厉打击严酷的采集站点.

3. 内部重复内容会受到惩罚吗?

对于此问题,百度目前的表述相对模糊. 在最近发布的“庆丰”算法中,百度强调不要过多地优化标题,并以关键字积累的形式增加排名. 含义是标题不应太重复.

一些SEO专家之前说过:

目前不提倡使用同义词或伪装关键字作为标题来创建多个页面来覆盖关键字. 尝试将其尽可能地精简为一篇文章,例如:

大豆的功效和功能

大豆的营养价值

通过这两个标题,您将看到多个食品网站上会有单独的页面,但是就其内容而言,答案几乎是相似的. 百度希望大家将这两个问题结合起来,例如: 大豆的营养价值,作用和功能是什么?

摘要: SEO是一种策略,尤其是当涉及重复内容和采集的内容时. 有时很难判断. 许多网站管理员正处在临界点. 如果您对重复的内容还有其他疑问,欢迎发表评论!

如何正确采集内容以进行网站优化?

采集交流 • 优采云 发表了文章 • 0 个评论 • 302 次浏览 • 2020-08-08 14:47

但是,搜索引擎强调内容的采集对网站意义不大,尤其是对于优化而言,甚至采集的内容也将被视为垃圾邮件,从而给网站造成负担. 实际上,即使采集的内容对网站没有影响,也可以. 但是,只要采集合理,它仍然有用,并且可以减少网站站长的原创烦恼并获得相同的优化效果. 那么,如何正确使用采集到的内容?

首先,内容的对象精美. 最好找到刚刚由其他人发布的内容作为采集目标,并在太多人重新发布之前采集它,但是内容的前提是它是前进的,新鲜的和有代表性的,而不是某些内容. 老式主题,否则将针对用户. 铜爵蜡的味道就不值一提了. 由于采集了内容,因此自然比原创内容要简单得多,因此您无需花费太多时间来编辑内容. 此时不要节省时间. 毕竟,采集的内容没有原创效果. 这很简单,因此您需要同时查找更多内容,以弥补蜘蛛的空虚.

第二,采集内容不采集标题. 每个人都知道,阅读文章时首先要看的是标题. 对于经过网站优化的搜索引擎,标题也具有一定的重要性. 采集的内容具有一定的长度,不能过多地更改,但是标题仅短短几个字,并且相对容易修改. 因此,标题的修改是必要的,最好将标题更改为原创标题. 完全不同,原因很简单. 网站优化. 当您看到标题相同但实质完全不同的文章时,读者会误解两者的内容是相同的. 相反,即使内容相同但标题完全不同,也会给出它. 人们有一种不容易被发现的新鲜感.

最后,对内容进行适当的调整. 尝试在自己的网站上采集内容的网站管理员肯定会发现直接复制的内容存在格式问题,因为一些聪明的原创创作者通常会向内容添加一些隐藏的内容,以防止采集内容. 格式,甚至版权都将标记在图片的ALT信息中. 如果您不注意,搜索引擎自然会将其识别为窃,对网站的危害是不言而喻的. 因此,必须对采集的内容进行格式化,并且必须转换英语格式的标点符号. 另外,可以将一些图片添加到内容中以使内容更丰富. 如果内容本身具有图片,则不要直接复制,最好是,另外,保存并上传到网站以及您自己的ALT信息,可以使采集到的内容更有价值.

简而言之,网站采集的内容并非完全没有帮助. 关键取决于您如何采集它. 只要您可以灵活地使用采集的内容,就可以为网站带来一定的好处. 网站优化,但网站管理员需要注意,必须掌握某些采集方法. 查看全部

在网站优化圈子中,网站管理员知道搜索引擎重视原创内容,但是无论SEOer面对长期的内容创建多么出色,都存在一定的困难. 不仅资源有限,而且书写能力也受到限制. 因此,整个网站,包括每个部分的内容,都无法避免被采集.

但是,搜索引擎强调内容的采集对网站意义不大,尤其是对于优化而言,甚至采集的内容也将被视为垃圾邮件,从而给网站造成负担. 实际上,即使采集的内容对网站没有影响,也可以. 但是,只要采集合理,它仍然有用,并且可以减少网站站长的原创烦恼并获得相同的优化效果. 那么,如何正确使用采集到的内容?

首先,内容的对象精美. 最好找到刚刚由其他人发布的内容作为采集目标,并在太多人重新发布之前采集它,但是内容的前提是它是前进的,新鲜的和有代表性的,而不是某些内容. 老式主题,否则将针对用户. 铜爵蜡的味道就不值一提了. 由于采集了内容,因此自然比原创内容要简单得多,因此您无需花费太多时间来编辑内容. 此时不要节省时间. 毕竟,采集的内容没有原创效果. 这很简单,因此您需要同时查找更多内容,以弥补蜘蛛的空虚.

第二,采集内容不采集标题. 每个人都知道,阅读文章时首先要看的是标题. 对于经过网站优化的搜索引擎,标题也具有一定的重要性. 采集的内容具有一定的长度,不能过多地更改,但是标题仅短短几个字,并且相对容易修改. 因此,标题的修改是必要的,最好将标题更改为原创标题. 完全不同,原因很简单. 网站优化. 当您看到标题相同但实质完全不同的文章时,读者会误解两者的内容是相同的. 相反,即使内容相同但标题完全不同,也会给出它. 人们有一种不容易被发现的新鲜感.

最后,对内容进行适当的调整. 尝试在自己的网站上采集内容的网站管理员肯定会发现直接复制的内容存在格式问题,因为一些聪明的原创创作者通常会向内容添加一些隐藏的内容,以防止采集内容. 格式,甚至版权都将标记在图片的ALT信息中. 如果您不注意,搜索引擎自然会将其识别为窃,对网站的危害是不言而喻的. 因此,必须对采集的内容进行格式化,并且必须转换英语格式的标点符号. 另外,可以将一些图片添加到内容中以使内容更丰富. 如果内容本身具有图片,则不要直接复制,最好是,另外,保存并上传到网站以及您自己的ALT信息,可以使采集到的内容更有价值.

简而言之,网站采集的内容并非完全没有帮助. 关键取决于您如何采集它. 只要您可以灵活地使用采集的内容,就可以为网站带来一定的好处. 网站优化,但网站管理员需要注意,必须掌握某些采集方法.

[花瓣网]花瓣网-采集瀑布流数据的思想的详细说明

采集交流 • 优采云 发表了文章 • 0 个评论 • 595 次浏览 • 2020-08-08 14:34

视觉外观是锯齿状的多列布局. 当页面滚动条向下滚动时,此布局将继续加载数据块并将其附加到当前尾部.

用户快速浏览的快速阅读模式可以在短时间内获得更多信息,而瀑布流中的延迟加载模式避免了用户单击鼠标的翻页操作.

拼凑而成的,固定宽度而不是固定高度的设计使页面与传统的矩阵图片布局模式不同,巧妙地使用了视觉层次结构,任意视线缓解了视觉疲劳,并给人以折衷主义的感觉.

关注年轻一代的个体心理. 因此,此页面布局在今天非常流行.

那么如何采集瀑布数据?

今天我们以花瓣网为例向您解释:

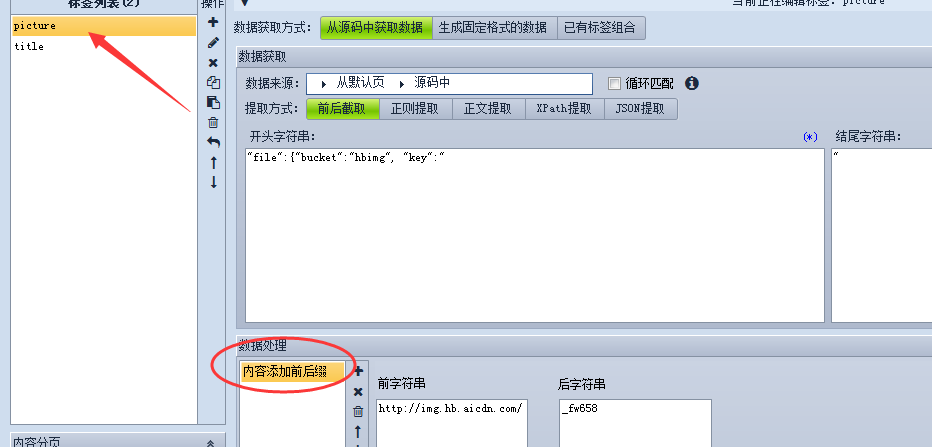

1. 获取网页后,分析网页形式,发现网页呈瀑布流形式,需要FIDDLER捕获后才能获取真实地址

将LIMIT参数修改为200,以便采集器可以获得200个列表页面.

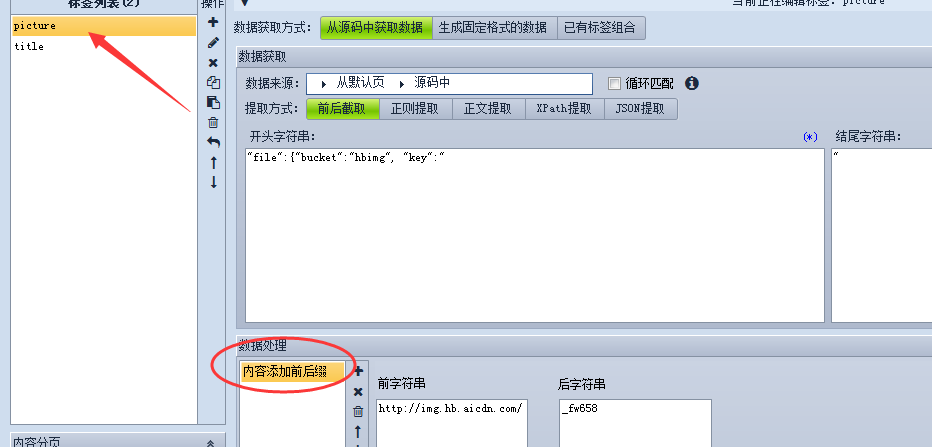

2. 编写URL采集规则

3. 获取列表页面后,设置内容采集规则

商业版本的功能用于图像采集,内容带有前缀和后缀.

注意: 此网页使用瀑布流格式,您需要捕获数据包以获得真实地址

FIDDLER数据包捕获教程

数据包捕获工具的合作伙伴可以从百度自行下载并安装它,操作非常简单.

联系我们

客户服务QQ: 800019423

客户服务电话:

购买软件: 查看全部

瀑布流,也称为瀑布流布局. 这是一种流行的网站页面布局.

视觉外观是锯齿状的多列布局. 当页面滚动条向下滚动时,此布局将继续加载数据块并将其附加到当前尾部.

用户快速浏览的快速阅读模式可以在短时间内获得更多信息,而瀑布流中的延迟加载模式避免了用户单击鼠标的翻页操作.

拼凑而成的,固定宽度而不是固定高度的设计使页面与传统的矩阵图片布局模式不同,巧妙地使用了视觉层次结构,任意视线缓解了视觉疲劳,并给人以折衷主义的感觉.

关注年轻一代的个体心理. 因此,此页面布局在今天非常流行.

那么如何采集瀑布数据?

今天我们以花瓣网为例向您解释:

1. 获取网页后,分析网页形式,发现网页呈瀑布流形式,需要FIDDLER捕获后才能获取真实地址

将LIMIT参数修改为200,以便采集器可以获得200个列表页面.

2. 编写URL采集规则

3. 获取列表页面后,设置内容采集规则

商业版本的功能用于图像采集,内容带有前缀和后缀.

注意: 此网页使用瀑布流格式,您需要捕获数据包以获得真实地址

FIDDLER数据包捕获教程

数据包捕获工具的合作伙伴可以从百度自行下载并安装它,操作非常简单.

联系我们

客户服务QQ: 800019423

客户服务电话:

购买软件:

SEO重复的内容和采集网站会受到惩罚吗?答案在这里

采集交流 • 优采云 发表了文章 • 0 个评论 • 325 次浏览 • 2020-08-08 13:56

1. 百度会惩罚重复的内容吗?

首先要弄清楚的是,重复内容和采集网站之间存在一定差异. 目前,百度没有明显的打击重复内容的迹象. 也可以理解,百度不会惩罚重复的内容.

尽管有很多SEO专家,但在进行网站诊断时,他们将讨论外部网站上重复内容的数量. 通常,他们将使用网站站长工具来计算原创链接是否已附加!

这是每个人都在苦苦挣扎的问题: 转发文章后,排名高于自己的排名. 百度显然已经在尝试解决这个问题,但它仍处于测试阶段. 我们可以在最近推出的Bear Paw中看到这一点,我希望授权的网站管理员可以在Bear's Paw帐户的原创保护下提交原创内容. 其中一项特别之处在于,文章发表的时间必须精确到第二次:

这是一个非常清晰的信号. 对于具有原创保护的网站,一旦提交的链接获得批准,原创标签将被添加到移动终端的搜索显示中,排名自然会高于转发的文章.

2. 为什么采集的内容的排名如此之高?

此处采集的内容应分为两种,主要是在以下两种情况下:

权威的网站转发

整个网站集

百度发布“熊掌”后,权威性网站转发将得到显着改善. 那么,为什么百度为这些网站提供较高的转发内容排名呢?这与网站的权限和原创性的比例有一定关系. 从信息传播的角度来看,更好地在搜索结果页面上显示高质量的文章是可以理解的,并且在重新发布权威网站时将附带版权链接,并且还将为新网站建立友好的外部链接.

整个网站的集合完全不同. 尽管采集大量内容将保持网站上不断更新的频率,但也将发现采集情况还不错,但是采集的内容几乎没有排名. 这也是当前新闻. 生存的一点理由!

百度发布了飓风算法后,很明显,它将严厉打击严酷的采集场所. 3.内部重复内容将受到惩罚

对于此问题,百度目前的表述相对模糊. 在最近发布的“庆丰”算法中,百度强调不要过多地优化标题,并以关键字积累的形式增加排名. 含义是标题不应太重复.

一些SEO专家之前说过:

目前不提倡使用同义词或伪装关键字作为标题来创建多个页面来覆盖关键字. 尝试将其尽可能地精简为一篇文章,例如:

大豆的功效和功能

大豆的营养价值

通过这两个标题,您将看到多个食品网站上会有单独的页面,但是就其内容而言,答案几乎是相似的. 百度希望大家将这两个问题结合起来,例如: 大豆的营养价值,作用和功能是什么?

摘要: SEO是一种策略,尤其是当涉及重复内容和采集的内容时. 有时很难判断. 许多网站管理员正处在临界点. 如果您对重复的内容还有其他疑问,欢迎发表评论! 查看全部

重复内容是SEO业界一直关注的问题. 搜索引擎会惩罚重复的内容吗?这是一个经常讨论的话题. 百度最近大量减少了内容采集站点的权利,但仍有很多我的朋友发现他的文章已被转载,其排名仍然高于其原著. 那么百度如何处理互联网上如此多的重复内容?

1. 百度会惩罚重复的内容吗?

首先要弄清楚的是,重复内容和采集网站之间存在一定差异. 目前,百度没有明显的打击重复内容的迹象. 也可以理解,百度不会惩罚重复的内容.

尽管有很多SEO专家,但在进行网站诊断时,他们将讨论外部网站上重复内容的数量. 通常,他们将使用网站站长工具来计算原创链接是否已附加!

这是每个人都在苦苦挣扎的问题: 转发文章后,排名高于自己的排名. 百度显然已经在尝试解决这个问题,但它仍处于测试阶段. 我们可以在最近推出的Bear Paw中看到这一点,我希望授权的网站管理员可以在Bear's Paw帐户的原创保护下提交原创内容. 其中一项特别之处在于,文章发表的时间必须精确到第二次:

这是一个非常清晰的信号. 对于具有原创保护的网站,一旦提交的链接获得批准,原创标签将被添加到移动终端的搜索显示中,排名自然会高于转发的文章.

2. 为什么采集的内容的排名如此之高?

此处采集的内容应分为两种,主要是在以下两种情况下:

权威的网站转发

整个网站集

百度发布“熊掌”后,权威性网站转发将得到显着改善. 那么,为什么百度为这些网站提供较高的转发内容排名呢?这与网站的权限和原创性的比例有一定关系. 从信息传播的角度来看,更好地在搜索结果页面上显示高质量的文章是可以理解的,并且在重新发布权威网站时将附带版权链接,并且还将为新网站建立友好的外部链接.

整个网站的集合完全不同. 尽管采集大量内容将保持网站上不断更新的频率,但也将发现采集情况还不错,但是采集的内容几乎没有排名. 这也是当前新闻. 生存的一点理由!

百度发布了飓风算法后,很明显,它将严厉打击严酷的采集场所. 3.内部重复内容将受到惩罚

对于此问题,百度目前的表述相对模糊. 在最近发布的“庆丰”算法中,百度强调不要过多地优化标题,并以关键字积累的形式增加排名. 含义是标题不应太重复.

一些SEO专家之前说过:

目前不提倡使用同义词或伪装关键字作为标题来创建多个页面来覆盖关键字. 尝试将其尽可能地精简为一篇文章,例如:

大豆的功效和功能

大豆的营养价值

通过这两个标题,您将看到多个食品网站上会有单独的页面,但是就其内容而言,答案几乎是相似的. 百度希望大家将这两个问题结合起来,例如: 大豆的营养价值,作用和功能是什么?

摘要: SEO是一种策略,尤其是当涉及重复内容和采集的内容时. 有时很难判断. 许多网站管理员正处在临界点. 如果您对重复的内容还有其他疑问,欢迎发表评论!

淄博网站优化中内容采集几个小技巧

采集交流 • 优采云 发表了文章 • 0 个评论 • 301 次浏览 • 2020-08-14 04:49

第一、文章的标题一定要更改

首先文章的标题是用户第一眼听到的,新的文章标题可以吸引用户点击访问页面,提升页面的访问量。同时在一个文章页面中,标题是权重最高的,新的标题可以使当页面能快速被搜索引擎收录。

第二、最好采集当下比较热门的信息内容

如果采集的内容都早已讨论多年,很多网民都已看过,再次点击阅读的兴趣就不会很大。另外讨论多年的话题搜索引擎也已经抓取了太多相关的页面,对于类似内容的页面抓取兴趣不会很大。

第三、做好内容再编辑

很多人对于伪原创的理解就是复制一些内容,然后中间插入自己写的内容,保证自己编撰内容的比列就可以了。这样做不是不可以,但疗效还不是最好。最好的是复制的内容按原先的意思自己重新组织语言编撰一遍,虽然这样比较浪费时间和精力,但疗效更好。

内容采集是网站优化中必不可少的一项工作,采集再编辑的好,对网站优化有很大的帮助。所以做好每一个小细节是极其重要的。 查看全部

淄博网站优化的日常维护中,内容和外链是两大法宝,这两点做好后,不害怕网站没有好的排行。而这两点中又以内容更新为重。但真正做网站优化的同学都有这样的感受,每天更新内容,实在是思虑枯竭。这里就少不得要从网上去采集别人的文章内容进行伪原创,但采集内容再编辑也是有一些小技巧的,做的好可以使文章快速被收录。

第一、文章的标题一定要更改

首先文章的标题是用户第一眼听到的,新的文章标题可以吸引用户点击访问页面,提升页面的访问量。同时在一个文章页面中,标题是权重最高的,新的标题可以使当页面能快速被搜索引擎收录。

第二、最好采集当下比较热门的信息内容

如果采集的内容都早已讨论多年,很多网民都已看过,再次点击阅读的兴趣就不会很大。另外讨论多年的话题搜索引擎也已经抓取了太多相关的页面,对于类似内容的页面抓取兴趣不会很大。

第三、做好内容再编辑

很多人对于伪原创的理解就是复制一些内容,然后中间插入自己写的内容,保证自己编撰内容的比列就可以了。这样做不是不可以,但疗效还不是最好。最好的是复制的内容按原先的意思自己重新组织语言编撰一遍,虽然这样比较浪费时间和精力,但疗效更好。

内容采集是网站优化中必不可少的一项工作,采集再编辑的好,对网站优化有很大的帮助。所以做好每一个小细节是极其重要的。

如何使采集的内容也有价值

采集交流 • 优采云 发表了文章 • 0 个评论 • 315 次浏览 • 2020-08-14 02:28

第二,排版方法要进行优化。采集别人的内容不能否将他人的网页排版也同样采集过来,这就等于复制了一个网页,显然会被百度觉得在剽窃或则作弊,同时也给用户带来不好的现象。对于排版而言,首先要结合自身网站整体的风格进行排版,然后要尽可能的降低广告图片或则其他的垃圾内容,让采集的内容愈加显现,这样可以实现网页的差异化排版。在这里一定要使采集的内容干净整洁,毕竟作为一个新网站,此时应用大量的广告其实没必要,因为无论是你网站的排行,还是点击率都极低,即使使用了百度广告联盟也不会给网站带来利润,所以此时关键要将网页内容排版进行优化,使可读性提高。

第三,采集的内容要尽可能的新鲜。现在互联网的信息更新速率很快,如果你的网站所采集的内容十分的旧,一方面同样的内容在网站上太多,难以得到用户的追捧,另一方面也很难获得收录,以及给予一定的排行。所以采集的内容一定要新鲜,因为此时的内容被转载的次数并不多,如果你提早采集,那么就有可能被百度收录,这样才能够起到较好的优化疗效。通常采集的内容不能够超过两天,尽量采集的内容是在一天之内的内容。当然那些内容采集之后,也须要经过前面两步工作的加工,这样就能明显提高内容的价值,并就能提高收录的可能性。

第四,适当的降低一些图片,同时还须要在图片中将Alt属性的内容填充。之所以如此做,可以利用图片来提高百度的收录,因为现今百度对于有Alt属性内容的图片具有较高的收录效率。而且内容上降低相应的图片,也才能有效提高用户的阅读体验。当然这儿的图片最好具有一定的原创性,或者图片的内涵要才能和内容具有一致性,千万不能否是一个技术类的文章却使用了大量美眉的图片,这样反倒会给内容带来极大的负面影响。 查看全部

第一,对标题和关键词、描述进行更改。这是最至少的操作,如果这种不改,很快都会被百度认定是剽窃,于是网站内容很难被百度收录,同时即使被收录,那么用户听到和别的网站一模一样的内容,再加上你的内容排行在后,显然得到的点击可能性极低。况且随着百度算法的进步,这种纯粹的剽窃采集模式,显然早已不合时宜。在这里将标题和关键词以及描述进行更改,一定要重视和上面的内容保持一致,而且还须要规避标题党的问题,内容和标题具有统一性,同时还须要具有一定的创新性,这样有助于吸引用户点击。

第二,排版方法要进行优化。采集别人的内容不能否将他人的网页排版也同样采集过来,这就等于复制了一个网页,显然会被百度觉得在剽窃或则作弊,同时也给用户带来不好的现象。对于排版而言,首先要结合自身网站整体的风格进行排版,然后要尽可能的降低广告图片或则其他的垃圾内容,让采集的内容愈加显现,这样可以实现网页的差异化排版。在这里一定要使采集的内容干净整洁,毕竟作为一个新网站,此时应用大量的广告其实没必要,因为无论是你网站的排行,还是点击率都极低,即使使用了百度广告联盟也不会给网站带来利润,所以此时关键要将网页内容排版进行优化,使可读性提高。

第三,采集的内容要尽可能的新鲜。现在互联网的信息更新速率很快,如果你的网站所采集的内容十分的旧,一方面同样的内容在网站上太多,难以得到用户的追捧,另一方面也很难获得收录,以及给予一定的排行。所以采集的内容一定要新鲜,因为此时的内容被转载的次数并不多,如果你提早采集,那么就有可能被百度收录,这样才能够起到较好的优化疗效。通常采集的内容不能够超过两天,尽量采集的内容是在一天之内的内容。当然那些内容采集之后,也须要经过前面两步工作的加工,这样就能明显提高内容的价值,并就能提高收录的可能性。

第四,适当的降低一些图片,同时还须要在图片中将Alt属性的内容填充。之所以如此做,可以利用图片来提高百度的收录,因为现今百度对于有Alt属性内容的图片具有较高的收录效率。而且内容上降低相应的图片,也才能有效提高用户的阅读体验。当然这儿的图片最好具有一定的原创性,或者图片的内涵要才能和内容具有一致性,千万不能否是一个技术类的文章却使用了大量美眉的图片,这样反倒会给内容带来极大的负面影响。

javascript 分页 如何采集内容

采集交流 • 优采云 发表了文章 • 0 个评论 • 347 次浏览 • 2020-08-13 21:30

:1108/eol_fenye.php?url=

复制代码

这样的地址,url参数就是踩到的内容页地址

外部php文件处理分页,根据原网站的分页规律生成优采云可采集的分页代码,输出原网站的源码+生成的分页代码,这样优采云就可以采集了

需要本地搭建php运行环境,有很多一键安装的集成包,我用的是discuz的ComsenzEXP,下载网站

安装后,要把php文件放在网站运行的目录里,ComsenzEXP默认C:\ComsenzEXP\wwwroot,把压缩包解压后上面的eol_fenye.php文件放在这儿即可

文件访问地址就是:1108/eol_fenye.php,要加url参数,:1108/eol_fenye.php?url=,可以看见分页疗效

外部插口我还不熟悉,获取源码的方法也可能会出现问题,路乱码等,需要学习改进,路有问题可以联系我

采集规则,分页区域设置见规则

php文件压缩包 查看全部

用外部的php文件处理下,就是把采集的内容页作为外部的php文件的递交参数,用自定义的方法把组合成

:1108/eol_fenye.php?url=

复制代码

这样的地址,url参数就是踩到的内容页地址

外部php文件处理分页,根据原网站的分页规律生成优采云可采集的分页代码,输出原网站的源码+生成的分页代码,这样优采云就可以采集了

需要本地搭建php运行环境,有很多一键安装的集成包,我用的是discuz的ComsenzEXP,下载网站

安装后,要把php文件放在网站运行的目录里,ComsenzEXP默认C:\ComsenzEXP\wwwroot,把压缩包解压后上面的eol_fenye.php文件放在这儿即可

文件访问地址就是:1108/eol_fenye.php,要加url参数,:1108/eol_fenye.php?url=,可以看见分页疗效

外部插口我还不熟悉,获取源码的方法也可能会出现问题,路乱码等,需要学习改进,路有问题可以联系我

采集规则,分页区域设置见规则

php文件压缩包

英文谷歌优化:熊掌号:SEO重复内容与采集站, 会被惩罚吗, 答案在这里!

采集交流 • 优采云 发表了文章 • 0 个评论 • 289 次浏览 • 2020-08-12 16:43

1、百度究竟是否会惩罚重复内容

这里首先须要明晰的是重复内容与采集站点,还是有一定区别的,目前来讲,百度对于重复内容并没有显著的严打征兆,也可以如此理解,百度对重复内容是不会惩罚的。

虽然这么好多SEO专家,在做网站诊断的时侯还会讨论外部站点重复内容的数目问题,正常来讲会通过站长工具来统计是否被附送原文链接!

这里你们始终苦恼的问题:文章被转发后,排名比自己的高,百度太明晰仍然在企图解决这个问题,但仍在测试阶段,这点我们可以在近来推出的熊掌号看出希望,有权限的站长,可以在熊掌号下的原创保护递交原创内容,其中太非常一点就是文章发布的时间须要精确到秒:

这是一个太明晰的讯号,拥有原创保护的站点,提交链接一旦初审通过,在移动端的搜索诠释上都会加注原创标签,排名自然都会比转发文章高。

2、采集内容排行为何这么高

这上面的采集内容,应该是一分为二的,主要有下边两种情况:

权威站点转发

整站采集

权威站点转发,在百度推出熊掌号后,会得到显著的改善,那么百度为何给与这部份站点的转发内容很高的排行,这与站点权威度以及原创比列有一定关系,同时为了更好的把优质文章展现今搜索结果页面,从信息传播的角度也是可以理解的,并且权威站点的转发,都会附送版权链接,给新站也是完善友好的外部链接。

整站采集就完全不同了,大批量的采集内容,虽然会保持网站有持续更新的频度,同时也会发觉收录还不错,但采集内容几乎没有排行,这也是目前新闻外链能够存活的一点点理由!

在百度推出飓风算法后,很明晰的心态就是严厉严打恶劣采集站点,看来日后连收录就会成为泡影。

3、内部重复内容是否会被惩罚

对于这个问题目前百度抒发的相对模糊,在近来推出的清风算法中,百度指出不要过多的优化标题,以关键词堆积等方式提升排行,言外之意,标题不要过分重复。

早前也有部份SEO专家表明:

利用反义词或是变相的关键词作为标题制造多个页面,来覆盖关键词目前来讲是不被倡导的,尽量精简到一篇文章中,比如:

大豆的功效与作用

大豆的营养价值

这两个标题,在多个小吃网站你会看见就会有独立的页面存在,但就其内容而言,答案几乎太相仿,百度会希望你们把这两个问题融合在一起,比如:大豆的营养价值,它的功效与作用有什么?

总结:SEO是一种策略,特别是面对重复内容与采集内容的时侯,有的时侯很难判定,很多站长走在临界点,如果你有更多关于重复内容的问题,欢迎留言评论! 查看全部

重复内容是SEO行业仍然关注的问题,重复内容究竟会不会被搜索引擎惩罚,这是一个被常常讨论的话题,百度近来对内容采集站点进行大批量的降权,但仍有太同事发觉自己的文章被转载,排名仍然比自己的原创高,那么互联网上这么多的重复内容,百度是怎样对待的呢?

1、百度究竟是否会惩罚重复内容

这里首先须要明晰的是重复内容与采集站点,还是有一定区别的,目前来讲,百度对于重复内容并没有显著的严打征兆,也可以如此理解,百度对重复内容是不会惩罚的。

虽然这么好多SEO专家,在做网站诊断的时侯还会讨论外部站点重复内容的数目问题,正常来讲会通过站长工具来统计是否被附送原文链接!

这里你们始终苦恼的问题:文章被转发后,排名比自己的高,百度太明晰仍然在企图解决这个问题,但仍在测试阶段,这点我们可以在近来推出的熊掌号看出希望,有权限的站长,可以在熊掌号下的原创保护递交原创内容,其中太非常一点就是文章发布的时间须要精确到秒:

这是一个太明晰的讯号,拥有原创保护的站点,提交链接一旦初审通过,在移动端的搜索诠释上都会加注原创标签,排名自然都会比转发文章高。

2、采集内容排行为何这么高

这上面的采集内容,应该是一分为二的,主要有下边两种情况:

权威站点转发

整站采集

权威站点转发,在百度推出熊掌号后,会得到显著的改善,那么百度为何给与这部份站点的转发内容很高的排行,这与站点权威度以及原创比列有一定关系,同时为了更好的把优质文章展现今搜索结果页面,从信息传播的角度也是可以理解的,并且权威站点的转发,都会附送版权链接,给新站也是完善友好的外部链接。

整站采集就完全不同了,大批量的采集内容,虽然会保持网站有持续更新的频度,同时也会发觉收录还不错,但采集内容几乎没有排行,这也是目前新闻外链能够存活的一点点理由!

在百度推出飓风算法后,很明晰的心态就是严厉严打恶劣采集站点,看来日后连收录就会成为泡影。

3、内部重复内容是否会被惩罚

对于这个问题目前百度抒发的相对模糊,在近来推出的清风算法中,百度指出不要过多的优化标题,以关键词堆积等方式提升排行,言外之意,标题不要过分重复。

早前也有部份SEO专家表明:

利用反义词或是变相的关键词作为标题制造多个页面,来覆盖关键词目前来讲是不被倡导的,尽量精简到一篇文章中,比如:

大豆的功效与作用

大豆的营养价值

这两个标题,在多个小吃网站你会看见就会有独立的页面存在,但就其内容而言,答案几乎太相仿,百度会希望你们把这两个问题融合在一起,比如:大豆的营养价值,它的功效与作用有什么?

总结:SEO是一种策略,特别是面对重复内容与采集内容的时侯,有的时侯很难判定,很多站长走在临界点,如果你有更多关于重复内容的问题,欢迎留言评论!

新浪微博内容数据采集爬虫如何写

采集交流 • 优采云 发表了文章 • 0 个评论 • 351 次浏览 • 2020-08-12 12:31

SinaSpider-基于scrapy和redis的分布式微博爬虫。SinaSpider主要爬取新浪微博的个人信息、微博数据、关注和粉丝。数据库设置Information、Tweets、Follows、Fans四张表。爬虫框架使用Scrapy,使用scrapy_redis和Redis实现分布式。此项目实现将单机的新浪微博爬虫重构成分布式爬虫。

sina_reptile-这是一个关于sina微博的爬虫,采用python开发,并更改了其sdk中的bug,采用mongodb储存,实现了多进程爬取任务。获取新浪微博1000w用户的基本信息和每位爬取用户近来发表的50条微博,使用python编撰,多进程爬取,将数据储存在了mongodb中

sina_weibo_crawler-基于urlib2及beautifulSoup实现的微博爬虫系统。利用urllib2加beautifulsoup爬取新浪微博,数据库采用mongodb,原创关系以txt文件储存,原创内容以csv方式储存,后期直接插入mongodb数据库

sina-weibo-crawler-方便扩充的新浪微博爬虫。WCrawler.crawl()函数只须要一个url参数,返回的用户粉丝、关注上面都有url,可以向外扩充爬取,并且也可以自定义一些过滤规则。

weibo_crawler-基于Python、BeautifulSoup、mysql微博搜索结果爬取工具。本工具使用模拟登陆来实现微博搜索结果的爬取。

SinaMicroblog_Creeper-Spider_VerificationCode-新浪微博爬虫,获得每位用户和关注的,粉丝的用户id存入xml文件中,BFS,可以模拟登录,模拟登录中的验证码会抓取出来使用户输入。

不过在这之前,一些功能和句型药了解,比如list,dict,切片,条件判定,文件读写操作等;

网页的基本知识,分析语言能力要具备;开发者工具会熟练运用; 查看全部

在不同的峰会和问答中,经常会遇见新浪微博的数据采集爬虫程序如何写,或是早已完成了某部份前面须要协助帮助如何做,楚江数据结合网上资料整理了几个微博爬虫开源项目。

SinaSpider-基于scrapy和redis的分布式微博爬虫。SinaSpider主要爬取新浪微博的个人信息、微博数据、关注和粉丝。数据库设置Information、Tweets、Follows、Fans四张表。爬虫框架使用Scrapy,使用scrapy_redis和Redis实现分布式。此项目实现将单机的新浪微博爬虫重构成分布式爬虫。

sina_reptile-这是一个关于sina微博的爬虫,采用python开发,并更改了其sdk中的bug,采用mongodb储存,实现了多进程爬取任务。获取新浪微博1000w用户的基本信息和每位爬取用户近来发表的50条微博,使用python编撰,多进程爬取,将数据储存在了mongodb中

sina_weibo_crawler-基于urlib2及beautifulSoup实现的微博爬虫系统。利用urllib2加beautifulsoup爬取新浪微博,数据库采用mongodb,原创关系以txt文件储存,原创内容以csv方式储存,后期直接插入mongodb数据库

sina-weibo-crawler-方便扩充的新浪微博爬虫。WCrawler.crawl()函数只须要一个url参数,返回的用户粉丝、关注上面都有url,可以向外扩充爬取,并且也可以自定义一些过滤规则。

weibo_crawler-基于Python、BeautifulSoup、mysql微博搜索结果爬取工具。本工具使用模拟登陆来实现微博搜索结果的爬取。

SinaMicroblog_Creeper-Spider_VerificationCode-新浪微博爬虫,获得每位用户和关注的,粉丝的用户id存入xml文件中,BFS,可以模拟登录,模拟登录中的验证码会抓取出来使用户输入。

不过在这之前,一些功能和句型药了解,比如list,dict,切片,条件判定,文件读写操作等;

网页的基本知识,分析语言能力要具备;开发者工具会熟练运用;

B2B 产品方法论(三):内容产出的流程以及内容团队的营运、协作与 SOP

采集交流 • 优采云 发表了文章 • 0 个评论 • 240 次浏览 • 2020-08-11 19:19

本文大纲:

第一篇先概论了用户下降&内容行销的方法论,介绍 SaaS 企业工具的产品核心、To B 与 To C 营销的最大差别在于决策链上多了“评估”这个环节。

第二篇则是进一步谈 B2B“行销与营运”的误区,不建议追求大量爆光与传播,应追求的是“转化”,以及怎样运用 Inbound Marketing 的方法,让企业用户觉得你是个值得信任的品牌。

【运营】透过一系列步骤去“生产内容”,目的是提升产品的价值,让用户的粘度、活跃度提高。

运营主要可分为两个阶段:

拉新(Leads)、使用(User)、付费转化(Active)用户管理和维系(VIP, Referral)

而接下来的第三篇,是 Inbound Marketing 概念的应用呈现,也就是也称的“内容行销”。

我会用一整篇,分享我在 JANDI 的“内容产出流程”,每一个环节为何这样设计,用了什么工具与技巧来协助我,以及怎样模式化运作。

内容行销的五个营运流程基本上可以分为“五步骤”:

采集:用户需求剖析,定位内容营运目标专题:将用户需求,转为产品需求创作/编辑/审核:模式化生产(以 Airtable 作为专案追踪与数据资料库)推送/排程:别急着喝棉花糖,等待时机快速测试/获取回馈/保持互动:建立社群、培养用户行惯一、采集:用户需求剖析,定位内容营运目标

第一个阶段,我们必须先“采集”,但这个采集的受词并不是内容素材,而是“用户需求”。

生产内容之前,我们必须先了解企业目前所处之环境、有多少资源、要达到哪些目标,才能开始行动。

根据现阶段的营运目标,进行“用户需求剖析”,定位受众的轮廓,找出对应的内容偏好。确立内容标准(背景与内容?如何与企业品牌价直观联结?文章撰写方向?),并且订出本次内容营运的目标(流量、转化的指标)用户需求剖析:用户场景问题解决方案

用户需求剖析,建议使用思维导图软件,快速展开,并且有效地排序优先次序。

用户需求剖析,可用“用户场景问题解决方案”的步骤来层层展开

二、专题:将用户需求,转为产品需求

第二个阶段,将上一阶段发散完的“用户需求”,收敛成“产品需求”。

以内容行销这个环节来看的话,其实就是“内容规划”。

而在 JANDI 内,我们称为——专题。

也就是在一段时间内,我们的内容生产必须符合此方向,让“内容有包围性”,也使我们的用户读者,可以更全面性的了解这议程。

举例来说,在 JANDI,我们每隔几个月会根据当时的行销策略、研究用户状况、时间与环境趋势,推出相对应的专题,例如 2018 年尾时,搭配圣诞,推出了以“转型、除旧布新”为主题的内容专题。

JANDI 内容专题的草案文件

收录:背景与内容、与公司品牌价值观的联结、时间、子标题、预计日程…等等资讯

三、创作/编辑/审核:模式化生产(Airtable)

再来是第三个阶段,当专题设定完成后,就有了个方向可以去采集内容素材,开始撰写内容了!

这个阶段是个漫长的流程,既然有流程就有模式化的流程图:

这是我们内部内容生产的流程图,做出 SOP 才能够有效益的模式化!

FAQ:为什么用 Airtable?

因为 Airtable 算是个全方为的智慧型资料库了,除了最基本的资料库检视之外,还有月历检视(一览文章的预定发布日),看板式检视(快速了解每位内容的状态,哪些 Delay 要处理,哪些还没画图)。

甚至,还能配合函数,将 utm 网址自动化产出,将一个文章设定一个 ID,就能手动形成对应的 utm 追踪网址。

不只是资料库的标准备配:“分析数据”好用,还能做专案管理,虽然介面全英语,但真的无可取代,有空的同学也可以试试玩儿(百分之九十九使你离开一点都不智慧的 Google Sheet XDD):点此使用Airtable

Airtable(一):先透过月历检视,找到自己被分配到的文章,查看日期是否可以接受,再填写自己预计完成的草稿日期(至少提早预计发布日两天)

Airtable(二),左图:看板式检视;右图:透过函示可以直接自动化 utm 追踪码

我们整篇文章,都会有一个专属 ID ,例如图中“TWM_Productivity_062”(台湾,Medium,Productivity 系列文章第 62 号),而我们的 CTA 的 utm 追踪码是:(网址会导到官网的用户注册页面)

#/zh-tw/campaign?campaignName=XXX&campaignSource=medium&campaignMedium=blog&campaignDest=register

其中的 XXX 就是该篇文章的 ID,这是我们公司自行开发的追踪系统(类似 Google Analytics),若有人点击此网址时,后台会纪录他以后的行为:

转化率指标:Register:多少人点击此网址;Confirmation Email:注册成功

这边分享一下 Airtable 自动化的函式(Formula),可以拿去参考,如何构建自动化的一串文字(我个人当时是研究了 1 个多小时才成功找到方式):

(“#/zh-tw/campaign?campaignName=”) & {文章 ID} & T(“&campaignSource=medium&campaignMedium=blog&campaignDest=register”)

Hint:{这边是变数},其他都是常数。

四、推送/排程:别急着喝棉花糖,等待时机!

第四个阶段,并没哪些很非常的要点,算是标准流程——根据大家目标用户的使用习惯,找到相对应的时间、管道,推送给她们。记住,不是写完就发,别急着喝棉花糖啊。

以我们自己来说,拥有主要下述四个管线,推送我们的新内容:

当然,还有跟其他外部媒体合作转载文章这个管线,但这等我在下一篇“谈数据”的时侯,再来好好谈谈“合作转载”需要注意的事。

五、快速测试/获取回馈/保持互动:建立社群,培养用户行惯!

最后,第五个阶段,就是简单粗鲁地快速测试而且迭代。

与用户保持互动,获取回馈,目的是“培养用户参与内容”的习惯。

切记,至少要有一个推播内容的管线,是可以与用户保持高频度互动的。

像是我们的互动管线就是“脸书f粉丝专页”,会在每一次专题的开始与结尾,透过优采云包&脸书机器人的方法,与用户保持互动,并且快速测试,获取回馈。

JANDI 2018 年末专题《如何变革,除旧布新?》的结尾优采云包策略

结论:内容行销,尽可能模式化,才有迹可循

“内容行销”是个公司由内,把自己的品牌价值观往外营运的过程,当然一个人也能做到,但在 B2B 的场景下,这并非一个人可以“完成”的事。

毕竟在每一个环节,都须要有人好好把关。我此次分享的“五步骤”,基本上每一个步骤都须要一个负责人(团队),整个流程才能完整。

一开始,我们团队只有少少的人,每个环节只能勉勉强强做到关键项目,没有办法顾忌到细节。

但如今,团队早已逐渐成熟,开始有了负责专题制做、社群互动与优采云包、用户剖析的专业靠谱朋友,所以整个内容营运的流程能够稳定发挥,持续输出品牌价值观的内容。

最后,尽可能地使流程弄成一个 SOP 模式化,无论使你们有迹可寻、更好协作之外,也是为了未来的新进朋友,能有个路径能快速上手。

就像我这系列方法论,也是希望使有须要的朋友们,能有迹可寻,找到参考运用在自己的工作上,不一定立刻起效,但起码有个方式可以参考,可以去验证。 查看全部

内容的产出可以分为五个阶段:采集用户需求,进行剖析 → 收敛需求成专题 → 模式化生产内容 → 排程推送管线 → 快速测试与迭代,建立社群培养用户习惯。

本文大纲:

第一篇先概论了用户下降&内容行销的方法论,介绍 SaaS 企业工具的产品核心、To B 与 To C 营销的最大差别在于决策链上多了“评估”这个环节。

第二篇则是进一步谈 B2B“行销与营运”的误区,不建议追求大量爆光与传播,应追求的是“转化”,以及怎样运用 Inbound Marketing 的方法,让企业用户觉得你是个值得信任的品牌。

【运营】透过一系列步骤去“生产内容”,目的是提升产品的价值,让用户的粘度、活跃度提高。

运营主要可分为两个阶段:

拉新(Leads)、使用(User)、付费转化(Active)用户管理和维系(VIP, Referral)

而接下来的第三篇,是 Inbound Marketing 概念的应用呈现,也就是也称的“内容行销”。

我会用一整篇,分享我在 JANDI 的“内容产出流程”,每一个环节为何这样设计,用了什么工具与技巧来协助我,以及怎样模式化运作。

内容行销的五个营运流程基本上可以分为“五步骤”:

采集:用户需求剖析,定位内容营运目标专题:将用户需求,转为产品需求创作/编辑/审核:模式化生产(以 Airtable 作为专案追踪与数据资料库)推送/排程:别急着喝棉花糖,等待时机快速测试/获取回馈/保持互动:建立社群、培养用户行惯一、采集:用户需求剖析,定位内容营运目标

第一个阶段,我们必须先“采集”,但这个采集的受词并不是内容素材,而是“用户需求”。

生产内容之前,我们必须先了解企业目前所处之环境、有多少资源、要达到哪些目标,才能开始行动。

根据现阶段的营运目标,进行“用户需求剖析”,定位受众的轮廓,找出对应的内容偏好。确立内容标准(背景与内容?如何与企业品牌价直观联结?文章撰写方向?),并且订出本次内容营运的目标(流量、转化的指标)用户需求剖析:用户场景问题解决方案

用户需求剖析,建议使用思维导图软件,快速展开,并且有效地排序优先次序。

用户需求剖析,可用“用户场景问题解决方案”的步骤来层层展开

二、专题:将用户需求,转为产品需求

第二个阶段,将上一阶段发散完的“用户需求”,收敛成“产品需求”。

以内容行销这个环节来看的话,其实就是“内容规划”。

而在 JANDI 内,我们称为——专题。

也就是在一段时间内,我们的内容生产必须符合此方向,让“内容有包围性”,也使我们的用户读者,可以更全面性的了解这议程。

举例来说,在 JANDI,我们每隔几个月会根据当时的行销策略、研究用户状况、时间与环境趋势,推出相对应的专题,例如 2018 年尾时,搭配圣诞,推出了以“转型、除旧布新”为主题的内容专题。

JANDI 内容专题的草案文件

收录:背景与内容、与公司品牌价值观的联结、时间、子标题、预计日程…等等资讯

三、创作/编辑/审核:模式化生产(Airtable)

再来是第三个阶段,当专题设定完成后,就有了个方向可以去采集内容素材,开始撰写内容了!

这个阶段是个漫长的流程,既然有流程就有模式化的流程图:

这是我们内部内容生产的流程图,做出 SOP 才能够有效益的模式化!

FAQ:为什么用 Airtable?

因为 Airtable 算是个全方为的智慧型资料库了,除了最基本的资料库检视之外,还有月历检视(一览文章的预定发布日),看板式检视(快速了解每位内容的状态,哪些 Delay 要处理,哪些还没画图)。

甚至,还能配合函数,将 utm 网址自动化产出,将一个文章设定一个 ID,就能手动形成对应的 utm 追踪网址。

不只是资料库的标准备配:“分析数据”好用,还能做专案管理,虽然介面全英语,但真的无可取代,有空的同学也可以试试玩儿(百分之九十九使你离开一点都不智慧的 Google Sheet XDD):点此使用Airtable

Airtable(一):先透过月历检视,找到自己被分配到的文章,查看日期是否可以接受,再填写自己预计完成的草稿日期(至少提早预计发布日两天)

Airtable(二),左图:看板式检视;右图:透过函示可以直接自动化 utm 追踪码

我们整篇文章,都会有一个专属 ID ,例如图中“TWM_Productivity_062”(台湾,Medium,Productivity 系列文章第 62 号),而我们的 CTA 的 utm 追踪码是:(网址会导到官网的用户注册页面)

#/zh-tw/campaign?campaignName=XXX&campaignSource=medium&campaignMedium=blog&campaignDest=register

其中的 XXX 就是该篇文章的 ID,这是我们公司自行开发的追踪系统(类似 Google Analytics),若有人点击此网址时,后台会纪录他以后的行为:

转化率指标:Register:多少人点击此网址;Confirmation Email:注册成功

这边分享一下 Airtable 自动化的函式(Formula),可以拿去参考,如何构建自动化的一串文字(我个人当时是研究了 1 个多小时才成功找到方式):

(“#/zh-tw/campaign?campaignName=”) & {文章 ID} & T(“&campaignSource=medium&campaignMedium=blog&campaignDest=register”)

Hint:{这边是变数},其他都是常数。

四、推送/排程:别急着喝棉花糖,等待时机!

第四个阶段,并没哪些很非常的要点,算是标准流程——根据大家目标用户的使用习惯,找到相对应的时间、管道,推送给她们。记住,不是写完就发,别急着喝棉花糖啊。

以我们自己来说,拥有主要下述四个管线,推送我们的新内容:

当然,还有跟其他外部媒体合作转载文章这个管线,但这等我在下一篇“谈数据”的时侯,再来好好谈谈“合作转载”需要注意的事。

五、快速测试/获取回馈/保持互动:建立社群,培养用户行惯!

最后,第五个阶段,就是简单粗鲁地快速测试而且迭代。

与用户保持互动,获取回馈,目的是“培养用户参与内容”的习惯。

切记,至少要有一个推播内容的管线,是可以与用户保持高频度互动的。

像是我们的互动管线就是“脸书f粉丝专页”,会在每一次专题的开始与结尾,透过优采云包&脸书机器人的方法,与用户保持互动,并且快速测试,获取回馈。

JANDI 2018 年末专题《如何变革,除旧布新?》的结尾优采云包策略

结论:内容行销,尽可能模式化,才有迹可循

“内容行销”是个公司由内,把自己的品牌价值观往外营运的过程,当然一个人也能做到,但在 B2B 的场景下,这并非一个人可以“完成”的事。

毕竟在每一个环节,都须要有人好好把关。我此次分享的“五步骤”,基本上每一个步骤都须要一个负责人(团队),整个流程才能完整。

一开始,我们团队只有少少的人,每个环节只能勉勉强强做到关键项目,没有办法顾忌到细节。

但如今,团队早已逐渐成熟,开始有了负责专题制做、社群互动与优采云包、用户剖析的专业靠谱朋友,所以整个内容营运的流程能够稳定发挥,持续输出品牌价值观的内容。

最后,尽可能地使流程弄成一个 SOP 模式化,无论使你们有迹可寻、更好协作之外,也是为了未来的新进朋友,能有个路径能快速上手。

就像我这系列方法论,也是希望使有须要的朋友们,能有迹可寻,找到参考运用在自己的工作上,不一定立刻起效,但起码有个方式可以参考,可以去验证。

大数据开发培训须要学习的内容,大数据开发培训课程大纲

采集交流 • 优采云 发表了文章 • 0 个评论 • 191 次浏览 • 2020-08-11 14:25

一、静态页面基础 1颗星

从技术层面来说,该阶段使用的技术代码很简单、易于学习、方便理解。从后期课程层来说,因为我们重点是大数据,但前期须要锻练编程技术与思维。经过我们多年开发和讲课的项目总监剖析,满足这两点,目前市场上最好理解和把握的技术是J2EE,但J2EE又离不开页面技术。所以第一阶段我们的重点是页面技术。采用市场上主流的HTMl+CSS。

二、JavaSE+JavaWeb 2颗星

称为Java基础,由浅入深的技术点、真实商业项目模块剖析、多种储存形式的设计与实现。该阶段是前四个阶段最最重要的阶段,因为前面所有阶段的都要基于此阶段,也是学习大数据紧密度最高的阶段。本阶段将第一次接触团队开发、产出具有前后台(第一阶段技术+第二阶段的技术综合应用)的真实项目。

三、 前端框架 3颗星

前两个阶段的基础上化静为动,可以实现使我们网页内容愈加的丰富,当然假如从市场人员层面来说,有专业的后端设计人员,我们设计本阶段的目标在于后端的技术可以更直观的锻练人的思维和设计能力。同时我们也将第二阶段的中级特点融入到本阶段。使学习者更上一层楼。

四、企业及开发框架 4颗星

从J2EE开发工程师的任职要求来说,该阶段所用到的技术是必须把握,而我们所授的课程是低于市场(市场上主流三大框架,我们进行七大框架技术传授)、而且有真实的商业项目驱动需求文档、概要设计、详细设计、源码测试、部署、安装指南等就会进行讲解。

五、初识大数据 3颗星

描述如下:

该阶段设计是为了使新人才能对大数据有一个相对的大概念如何相对呢?在后置课程JAVA的学习之后才能理解程序在单机的笔记本上是怎样运行的。现在,大数据呢?大数据是将程序运行在大规模机器的集群中处理。大数据其实是要处理数据,所以同样,数据的储存从单机储存变为多机器大规模的集群储存。(你问我哪些是集群?好,我有一大锅饭,我一个人可以喝完,但是要许久,现在我叫你们一起喝。一个人的时侯叫人,人多了呢? 是不是叫人群啊!)

那么大数据可以初略的分为: 大数据储存和大数据处理

所以在这个阶段中呢,我们课程设计了大数据的标准:HADOOP

大数据的运行呢并不是在咋们常常使用的WINDOWS 7或则W10里面,而是

现在使用最广泛的系统:LINUX。

六、大数据数据库 4颗星

描述如下:

该阶段设计是为了使你们在理解大数据怎样处理大规模的数据的同时。简化咋们的编撰程序时间,同时提升读取速率。

怎么简化呢?在第一阶段中,如果须要进行复杂的业务关联与数据挖掘,自行编撰MR程序是十分繁琐的。所以在这一阶段中我们引入了HIVE,大数据中的数据库房。这里有一个关键字,数据库房。我晓得你要问我,所以我先说,数据库房呢用

来做数据挖掘剖析的,通常是一个超大的数据中心,存储这种数据的呢,一般ORACLE,DB2,等小型数据库,这些数据库一般用作实时的在线业务。

总之,要基于数据库房剖析数据呢速率是相对较慢的。但是便捷在于只要熟悉SQL,学习上去相对简单,而HIVE呢就是这样一种工具,基于大数据的SQL查询工具

呐,这一阶段呢还包括HBASE,它为大数据上面的数据库。

纳闷了,不是学了一种称作HIVE的数据“仓库”了么?HIVE是基于MR的所以

查询上去相当慢,HBASE呢基于大数据可以做到实时的数据查询。一个主剖析,

另一个主查询

七、实时数据采集 4颗星

描述如下:

前面的阶段数据来源是基于早已存在的大规模数据集来做的,数据处理与剖析之后

的结果是存在一定延时的,通常处理的数据为前一天的数据。

举例场景:网站防盗链,客户帐户异常,实时征信,遇到这种场景基于前一天的数

据剖析下来之后呢?是否很晚了。所以在本阶段中我们引入了实时的数据采集与分

析。主要包括了:FLUME实时数据采集,采集的来源支持十分广泛,KAFKA数据

数据接收与发送,STORM实时数据处理,数据处理秒级别

八、spark数据剖析 5颗星

描述如下:

同样先说后面的阶段,主要是第一阶段。HADOOP呢在剖析速率上基于MR的大规模数据集相对来说还是很慢的,包括机器学习,人工智能等。而且不适宜做迭代估算。SPARK呢在剖析上是作为MR的取代产品,怎么取代呢? 先说她们的运行机制,HADOOP基于磁盘存储剖析,而SPARK基于内存分析。我这么说你可能不懂,再形象一点,就像你要坐优采云从上海到南京,MR就是绿皮优采云,而SPARK是铁路或则磁悬浮。而SPARK呢是基于SCALA语言开发的,当然对SCALA支持最好,所以课程中先学习SCALA开发语言。什么?又要学另外一种开发语言?不不不!!!我只说一句话:SCALA是基于JAVA做的。

总结:在课程的设计方面,市面上的职位要求技术,基本全覆盖。而且并不是单纯的为了覆盖职位要求,而是本身课程从前到后就是一个完整的大数据项目流程,一环扣一环。

比如从历史数据的储存,分析(HADOOP,HIVE,HBASE),到实时的数据储存(FLUME,KAFKA),分析(STORM,SPARK),这些在真实的项目中都是相互依赖存在的。 查看全部

大数据要学习哪些内容呢?科多大数据带你们来瞧瞧大数据开发课程大纲。

一、静态页面基础 1颗星

从技术层面来说,该阶段使用的技术代码很简单、易于学习、方便理解。从后期课程层来说,因为我们重点是大数据,但前期须要锻练编程技术与思维。经过我们多年开发和讲课的项目总监剖析,满足这两点,目前市场上最好理解和把握的技术是J2EE,但J2EE又离不开页面技术。所以第一阶段我们的重点是页面技术。采用市场上主流的HTMl+CSS。

二、JavaSE+JavaWeb 2颗星

称为Java基础,由浅入深的技术点、真实商业项目模块剖析、多种储存形式的设计与实现。该阶段是前四个阶段最最重要的阶段,因为前面所有阶段的都要基于此阶段,也是学习大数据紧密度最高的阶段。本阶段将第一次接触团队开发、产出具有前后台(第一阶段技术+第二阶段的技术综合应用)的真实项目。

三、 前端框架 3颗星

前两个阶段的基础上化静为动,可以实现使我们网页内容愈加的丰富,当然假如从市场人员层面来说,有专业的后端设计人员,我们设计本阶段的目标在于后端的技术可以更直观的锻练人的思维和设计能力。同时我们也将第二阶段的中级特点融入到本阶段。使学习者更上一层楼。

四、企业及开发框架 4颗星

从J2EE开发工程师的任职要求来说,该阶段所用到的技术是必须把握,而我们所授的课程是低于市场(市场上主流三大框架,我们进行七大框架技术传授)、而且有真实的商业项目驱动需求文档、概要设计、详细设计、源码测试、部署、安装指南等就会进行讲解。

五、初识大数据 3颗星

描述如下:

该阶段设计是为了使新人才能对大数据有一个相对的大概念如何相对呢?在后置课程JAVA的学习之后才能理解程序在单机的笔记本上是怎样运行的。现在,大数据呢?大数据是将程序运行在大规模机器的集群中处理。大数据其实是要处理数据,所以同样,数据的储存从单机储存变为多机器大规模的集群储存。(你问我哪些是集群?好,我有一大锅饭,我一个人可以喝完,但是要许久,现在我叫你们一起喝。一个人的时侯叫人,人多了呢? 是不是叫人群啊!)

那么大数据可以初略的分为: 大数据储存和大数据处理

所以在这个阶段中呢,我们课程设计了大数据的标准:HADOOP

大数据的运行呢并不是在咋们常常使用的WINDOWS 7或则W10里面,而是

现在使用最广泛的系统:LINUX。

六、大数据数据库 4颗星

描述如下:

该阶段设计是为了使你们在理解大数据怎样处理大规模的数据的同时。简化咋们的编撰程序时间,同时提升读取速率。

怎么简化呢?在第一阶段中,如果须要进行复杂的业务关联与数据挖掘,自行编撰MR程序是十分繁琐的。所以在这一阶段中我们引入了HIVE,大数据中的数据库房。这里有一个关键字,数据库房。我晓得你要问我,所以我先说,数据库房呢用

来做数据挖掘剖析的,通常是一个超大的数据中心,存储这种数据的呢,一般ORACLE,DB2,等小型数据库,这些数据库一般用作实时的在线业务。

总之,要基于数据库房剖析数据呢速率是相对较慢的。但是便捷在于只要熟悉SQL,学习上去相对简单,而HIVE呢就是这样一种工具,基于大数据的SQL查询工具

呐,这一阶段呢还包括HBASE,它为大数据上面的数据库。

纳闷了,不是学了一种称作HIVE的数据“仓库”了么?HIVE是基于MR的所以

查询上去相当慢,HBASE呢基于大数据可以做到实时的数据查询。一个主剖析,

另一个主查询

七、实时数据采集 4颗星

描述如下:

前面的阶段数据来源是基于早已存在的大规模数据集来做的,数据处理与剖析之后

的结果是存在一定延时的,通常处理的数据为前一天的数据。

举例场景:网站防盗链,客户帐户异常,实时征信,遇到这种场景基于前一天的数

据剖析下来之后呢?是否很晚了。所以在本阶段中我们引入了实时的数据采集与分

析。主要包括了:FLUME实时数据采集,采集的来源支持十分广泛,KAFKA数据

数据接收与发送,STORM实时数据处理,数据处理秒级别

八、spark数据剖析 5颗星

描述如下:

同样先说后面的阶段,主要是第一阶段。HADOOP呢在剖析速率上基于MR的大规模数据集相对来说还是很慢的,包括机器学习,人工智能等。而且不适宜做迭代估算。SPARK呢在剖析上是作为MR的取代产品,怎么取代呢? 先说她们的运行机制,HADOOP基于磁盘存储剖析,而SPARK基于内存分析。我这么说你可能不懂,再形象一点,就像你要坐优采云从上海到南京,MR就是绿皮优采云,而SPARK是铁路或则磁悬浮。而SPARK呢是基于SCALA语言开发的,当然对SCALA支持最好,所以课程中先学习SCALA开发语言。什么?又要学另外一种开发语言?不不不!!!我只说一句话:SCALA是基于JAVA做的。

总结:在课程的设计方面,市面上的职位要求技术,基本全覆盖。而且并不是单纯的为了覆盖职位要求,而是本身课程从前到后就是一个完整的大数据项目流程,一环扣一环。

比如从历史数据的储存,分析(HADOOP,HIVE,HBASE),到实时的数据储存(FLUME,KAFKA),分析(STORM,SPARK),这些在真实的项目中都是相互依赖存在的。

通过网路爬虫采集大数据

采集交流 • 优采云 发表了文章 • 0 个评论 • 357 次浏览 • 2020-08-11 00:11

在互联网时代,网络爬虫主要是为搜索引擎提供最全面和最新的数据。

在大数据时代,网络爬虫更是从互联网上采集数据的有利工具。目前早已晓得的各类网路爬虫工具早已有上百个,网络爬虫工具基本可以分为 3 类。

本节首先对网路爬虫的原理和工作流程进行简单介绍,然后对网路爬虫抓取策略进行讨论,最后对典型的网路工具进行描述。网络爬虫原理网络爬虫是一种根据一定的规则,自动地抓取 Web 信息的程序或则脚本。

Web 网络爬虫可以手动采集所有其才能访问到的页面内容,为搜索引擎和大数据剖析提供数据来源。从功能上来讲,爬虫通常有数据采集、处理和储存 3 部分功能,如图 1 所示。

图 1 网络爬虫示意

网页中不仅收录供用户阅读的文字信息外,还收录一些超链接信息。

网络爬虫系统正是通过网页中的超链接信息不断获得网路上的其他网页的。网络爬虫从一个或若干初始网页的 URL 开始,获得初始网页上的 URL,在抓取网页的过程中,不断从当前页面上抽取新的 URL 放入队列,直到满足系统的一定停止条件。

网络爬虫系统通常会选择一些比较重要的、出度(网页中链出的超链接数)较大的网站的 URL 作为种子 URL 集合。

网络爬虫系统以这种种子集合作为初始 URL,开始数据的抓取。因为网页中富含链接信息,通过已有网页的 URL 会得到一些新的 URL。

可以把网页之间的指向结构视为一个森林,每个种子 URL 对应的网页是森林中的一棵树的根结点,这样网路爬虫系统就可以按照广度优先搜索算法或则深度优先搜索算法遍历所有的网页。

由于深度优先搜索算法可能会让爬虫系统深陷一个网站内部,不利于搜索比较紧靠网站首页的网页信息,因此通常采用广度优先搜索算法采集网页。

网络爬虫系统首先将种子 URL 放入下载队列,并简单地从队首取出一个 URL 下载其对应的网页,得到网页的内容并将其储存后,经过解析网页中的链接信息可以得到一些新的 URL。

其次,根据一定的网页分析算法过滤掉与主题无关的链接,保留有用的链接并将其倒入等待抓取的 URL 队列。

最后,取出一个 URL,对其对应的网页进行下载,然后再解析,如此反复进行,直到遍历了整个网路或则满足某种条件后才能停止出来。网络爬虫工作流程如图 2 所示,网络爬虫的基本工作流程如下。

1)首先选定一部分种子 URL。

2)将这种 URL 放入待抓取 URL 队列。

3)从待抓取 URL 队列中取出待抓取 URL,解析 DNS,得到主机的 IP 地址,并将 URL 对应的网页下载出来,存储到已下载网页库中。此外,将这种 URL 放进已抓取 URL 队列。

4)分析已抓取 URL 队列中的 URL,分析其中的其他 URL,并且将这种 URL 放入待抓取 URL 队列,从而步入下一个循环。

图 2网路爬虫的基本工作流程

网络爬虫抓取策略Google 和百度等通用搜索引擎抓取的网页数目一般都是以亿为单位估算的。那么,面对这么诸多的网页,通过何种方法能够让网络爬虫尽可能地遍历所有网页,从而尽可能地扩大网页信息的抓取覆盖面,这是网路爬虫系统面对的一个太关键的问题。在网路爬虫系统中,抓取策略决定了抓取网页的次序。

本节首先对网路爬虫抓取策略用到的基本概念做简单介绍。1)网页间关系模型从互联网的结构来看,网页之间通过数目不等的超链接互相联接,形成一个彼此关联、庞大复杂的有向图。

如图 3 所示,如果将网页看成是图中的某一个结点,而将网页中指向其他网页的链接看成是这个结点指向其他结点的边,那么我们很容易将整个互联网上的网页建模成一个有向图。

理论上讲,通过遍历算法遍历该图,可以访问到互联网上几乎所有的网页。

图 3网页关系模型图

2)网页分类从爬虫的角度对互联网进行界定,可以将互联网的所有页面分为 5 个部份:已下载未过期网页、已下载已过期网页、待下载网页、可知网页和不可知网页,如图 4 所示。

抓取到本地的网页实际上是互联网内容的一个镜像与备份。互联网是动态变化的,当一部分互联网上的内容发生变化后,抓取到本地的网页就过期了。所以,已下载的网页分为已下载未过期网页和已下载已过期网页两类。

图 4 网页分类

待下载网页是指待抓取 URL 队列中的这些页面。

可知网页是指还没有抓取出来,也没有在待抓取 URL 队列中,但是可以通过对已抓取页面或则待抓取 URL 对应页面进行剖析,从而获取到的网页。

还有一部分网页,网络爬虫是难以直接抓取下载的,称为不可知网页。

下面重点介绍几种常见的抓取策略。1. 通用网路爬虫通用网路爬虫又称全网爬虫,爬行对象从一些种子 URL 扩展到整个 Web,主要为门户站点搜索引擎和小型 Web 服务提供商采集数据。

为提升工作效率,通用网路爬虫会采取一定的爬行策略。常用的爬行策略有深度优先策略和广度优先策略。

1)深度优先策略

深度优先策略是指网络爬虫会从起始页开始,一个链接一个链接地跟踪下去,直到不能再深入为止。

网络爬虫在完成一个爬行分支后返回到上一链接结点进一步搜索其他链接。当所有链接遍历完后,爬行任务结束。

这种策略比较适宜垂直搜索或站内搜索,但爬行页面内容层次较深的站点时会导致资源的巨大浪费。

以图 3 为例,遍历的路径为 1→2→5→6→3→7→4→8。

在深度优先策略中,当搜索到某一个结点的时侯,这个结点的子结点及该子结点的后继结点全部优先于该结点的兄弟结点,深度优先策略在搜索空间的时侯会尽量地往深处去,只有找不到某结点的后继结点时才考虑它的兄弟结点。

这样的策略就决定了深度优先策略不一定能找到最优解,并且因为深度的限制甚至找不到解。

如果不加限制,就会顺着一条路径无限制地扩充下去,这样才会“陷入”到巨大的数据量中。一般情况下,使用深度优先策略就会选择一个合适的深度,然后反复地搜索,直到找到解,这样搜索的效率就增加了。所以深度优先策略通常在搜索数据量比较小的时侯才使用。

2)广度优先策略

广度优先策略根据网页内容目录层次深浅来爬行页面,处于较浅目录层次的页面首先被爬行。当同一层次中的页面爬行完毕后,爬虫再深入下一层继续爬行。

仍然以图 3 为例,遍历的路径为 1→2→3→4→5→6→7→8

由于广度优先策略是对第 N 层的结点扩充完成后才步入第 N+1 层的,所以可以保证以最短路径找到解。

这种策略才能有效控制页面的爬行深度,避免碰到一个无穷深层分支时未能结束爬行的问题,实现便捷,无须储存大量中间结点,不足之处在于需较长时间能够爬行到目录层次较深的页面。

如果搜索时分支过多,也就是结点的后继结点太多,就会让算法用尽资源,在可以借助的空间內找不到解。2. 聚焦网路爬虫聚焦网路爬虫又称主题网路爬虫,是指选择性地爬行这些与预先定义好的主题相关的页面的网路爬虫。

1)基于内容评价的爬行策略

DeBra 将文本相似度的估算方式引入到网路爬虫中,提出了 Fish Search 算法。

该算法将用户输入的查询词作为主题,收录查询词的页面被视为与主题相关的页面,其局限性在于难以评价页面与主题相关度的大小。

Herseovic 对 Fish Search 算法进行了改进,提出了 Shark Search 算法,即借助空间向量模型估算页面与主题的相关度大小。

采用基于连续值估算链接价值的方式,不但可以估算出什么抓取的链接和主题相关,还可以得到相关度的量化大小。

2)基于链接结构评价的爬行策略

网页不同于通常文本,它是一种半结构化的文档,收录了许多结构化的信息。

网页不是单独存在的,页面中的链接指示了页面之间的互相关系,基于链接结构的搜索策略模式借助这种结构特点来评价页面和链接的重要性,以此决定搜索的次序。其中,PageRank 算法是这类搜索策略模式的代表。

PageRank 算法的基本原理是,如果一个网页多次被引用,则可能是很重要的网页,如果一个网页没有被多次引用,但是被重要的网页引用,也有可能是重要的网页。一个网页的重要性被平均地传递到它所引用的网页上。

将某个页面的 PageRank 除以存在于这个页面的正向链接,并将得到的值分别和正向链接所指的页面的 PageRank 相加,即得到了被链接的页面的 PageRank。

如图 5 所示,PageRank 值为 100 的网页把它的重要性平均传递给了它所引用的两个页面,每个页面获得了 50,同样 PageRank 值为 9 的网页给它所引用的 3 个页面的每位页面传递的值为 3。

PageRank 值为 53 的页面的值来源于两个引用了它的页面传递过来的值。

、

图 5 PageRank 算法示例

3)基于提高学习的爬行策略

Rennie 和 McCallum 将提高学习引入聚焦爬虫,利用贝叶斯分类器,根据整个网页文本和链接文本对超链接进行分类,为每位链接估算出重要性,从而决定链接的访问次序。

4)基于语境图的爬行策略