php抓取网页域名

php抓取网页域名的报价:.php视情况升级框架

网站优化 • 优采云 发表了文章 • 0 个评论 • 90 次浏览 • 2022-09-05 22:02

php抓取网页域名的报价:.php楼主你查一下搜狗.php做的网站报价..php视情况升级php框架,比如用hibernate.当然hibernate也是不错的

企业最好的选择是laravel\ci\php+mysql/smarty...其次是php7和node.js。web只是一个小部分,不要纠结这些。

swoole

php+apache+mysql。

用php+mysql好多数据是比较靠谱的.

还有yii吗?

laravel,这个开源框架还是很好用的,laravel就是基于php5的mvc设计,基于web开发相对比较容易。

针对国内现状,可以建议选择《图灵教育|学习型开发,从这个开始》系列课程,中心主要讲解企业应用系统的开发。课程的主要目的是为那些缺乏工程实践的学生和企业技术专家提供课程。这个系列由thoughtworks全球技术总监李典通过大量的项目开发经验讲解企业应用系统开发的基本概念、思想和技术。课程主要面向:企业级应用系统开发过程中遇到的技术瓶颈、企业应用开发中技术的成本、开发中出现的问题、学习能力的培养等。

讲师团队来自阿里、腾讯、百度、海尔、360、腾讯等知名企业。从以下4点上对企业应用系统的开发做详细讲解:php语言基础,可以看李典老师在讲解php时,带领大家掌握6个核心:nofile、文件上传、文件读写、lbs定位、文件权限、mongodb,用来解决网站不安全的问题。nginx反向代理,提高系统带宽性。

mysql数据库,提高系统的性能。redis缓存,提高系统的性能。webserver,解决网站速度慢。解决企业应用程序性能问题的一个较有效方法,就是采用分布式、虚拟化等高性能服务器,使其代价低于并发量,相当于将cpu资源划分为很多资源池,这样实现资源的互相隔离。以下是我自己学习时整理的“基于php语言的整站架构”。 查看全部

php抓取网页域名的报价:.php视情况升级框架

php抓取网页域名的报价:.php楼主你查一下搜狗.php做的网站报价..php视情况升级php框架,比如用hibernate.当然hibernate也是不错的

企业最好的选择是laravel\ci\php+mysql/smarty...其次是php7和node.js。web只是一个小部分,不要纠结这些。

swoole

php+apache+mysql。

用php+mysql好多数据是比较靠谱的.

还有yii吗?

laravel,这个开源框架还是很好用的,laravel就是基于php5的mvc设计,基于web开发相对比较容易。

针对国内现状,可以建议选择《图灵教育|学习型开发,从这个开始》系列课程,中心主要讲解企业应用系统的开发。课程的主要目的是为那些缺乏工程实践的学生和企业技术专家提供课程。这个系列由thoughtworks全球技术总监李典通过大量的项目开发经验讲解企业应用系统开发的基本概念、思想和技术。课程主要面向:企业级应用系统开发过程中遇到的技术瓶颈、企业应用开发中技术的成本、开发中出现的问题、学习能力的培养等。

讲师团队来自阿里、腾讯、百度、海尔、360、腾讯等知名企业。从以下4点上对企业应用系统的开发做详细讲解:php语言基础,可以看李典老师在讲解php时,带领大家掌握6个核心:nofile、文件上传、文件读写、lbs定位、文件权限、mongodb,用来解决网站不安全的问题。nginx反向代理,提高系统带宽性。

mysql数据库,提高系统的性能。redis缓存,提高系统的性能。webserver,解决网站速度慢。解决企业应用程序性能问题的一个较有效方法,就是采用分布式、虚拟化等高性能服务器,使其代价低于并发量,相当于将cpu资源划分为很多资源池,这样实现资源的互相隔离。以下是我自己学习时整理的“基于php语言的整站架构”。

php抓取网页域名可以使用正则表达式匹配。匹配的好处

网站优化 • 优采云 发表了文章 • 0 个评论 • 88 次浏览 • 2022-08-16 21:01

php抓取网页域名可以使用正则表达式匹配。正则表达式匹配的好处在于它简单快捷,没有计算机编程基础的人也能根据正则表达式有很快的查找、匹配和循环计算。我看有人发过这个网址,应该算比较详细了。网址:php抓取天猫网站。如果需要对比评价什么的,用js自身可以转换。目前经常用到。

php的话,可以用正则表达式来抓取天猫评价。正则表达式是一种语法,可以匹配任何符合正则表达式的字符串。要获取评价的话,可以在天猫右侧,找到评价的链接,解析出评价列表的php代码。

自己写爬虫:*使用框架:requests或者beautifulsoup库*手动爬取:拿手机端为例:selenium+androidstudio,这个属于开发工具,具体是使用这个工具的php爬虫,还是自己写的爬虫,

java可以先用requests来抓取,selenium是要用到androidstudio才可以使用。你可以先理一下业务逻辑,再找一下框架,其实没太大的区别。

php一般可以用requests库爬取,你可以根据业务逻辑分析需要的评价,这样可以方便google、百度、bing、搜狗等等这些搜索引擎抓取并识别评价中的商品,从而得到商品数据。你完全可以通过定制的思维完成获取评价业务逻辑的整合与分析。 查看全部

php抓取网页域名可以使用正则表达式匹配。匹配的好处

php抓取网页域名可以使用正则表达式匹配。正则表达式匹配的好处在于它简单快捷,没有计算机编程基础的人也能根据正则表达式有很快的查找、匹配和循环计算。我看有人发过这个网址,应该算比较详细了。网址:php抓取天猫网站。如果需要对比评价什么的,用js自身可以转换。目前经常用到。

php的话,可以用正则表达式来抓取天猫评价。正则表达式是一种语法,可以匹配任何符合正则表达式的字符串。要获取评价的话,可以在天猫右侧,找到评价的链接,解析出评价列表的php代码。

自己写爬虫:*使用框架:requests或者beautifulsoup库*手动爬取:拿手机端为例:selenium+androidstudio,这个属于开发工具,具体是使用这个工具的php爬虫,还是自己写的爬虫,

java可以先用requests来抓取,selenium是要用到androidstudio才可以使用。你可以先理一下业务逻辑,再找一下框架,其实没太大的区别。

php一般可以用requests库爬取,你可以根据业务逻辑分析需要的评价,这样可以方便google、百度、bing、搜狗等等这些搜索引擎抓取并识别评价中的商品,从而得到商品数据。你完全可以通过定制的思维完成获取评价业务逻辑的整合与分析。

【外链建设】测试了1500个hao123推荐的网站,只为挖掘发能外链的DZ论坛

网站优化 • 优采云 发表了文章 • 0 个评论 • 99 次浏览 • 2022-06-19 03:20

点击上面“蓝字”关注!

虽然已经过了外链为皇的时代,但外链在新站建设、重点关键词排名等工作场景中依然占据着很重要的位置。

因为我工作后,大部分的时间在做品牌SEO,没有积攒什么外链资源;这次要梳理SEO技术,我的新博客也需要扩大外链的广泛度。所以前期会在积累外链资源先发力一些。

首先说下为什么从hao123上找外链!网络上的网址千千万,搜索引擎蜘蛛抓取网络中的内容总要有个起点,这个起点就叫“种子站点”。hao123这类网站就是优质的种子站点。关于种子站点的具体含义,可以参考《走进搜索引擎》。

目前论坛外链作用不大,而且很多论坛已经不能发了,这次只是做一个初步尝试。后续会开拓更多类型平台中的外链资源,如目录站点、b2b网站外链等,也会逐步分析我挖掘外链资源的方法和外链建设的策略。

第一步,获取所有hao123推荐链接

hao123论坛推荐页面:

获取本页面所有的网站,共发现212个。

(如有需要,可以加我的微信或者加入我的知识星球)

第二步,获取所有hao123推荐链接的友情链接,0层,1层

利用上一步获得的212个网站,批量查询所有网站的友情链接,并保存。

本次共获得网站数量1452个,平均每个网站的外链数量是:6.8个。过程中,发现很多网站已经不能访问,只能删除;还有大量网站是同一个域名出现多个二、三级域名。也只能通过程序删除,最终剩下1007个站点。提取根域名的方法还比较麻烦,感兴趣的可以看这里python提取根域名(博客中查看)。

第三部:检查网站SEO数据

本来第三步打算开始检测是否是DZ程序的,但后面发现很多网站的权重已经是0了,根本没有挖掘意义,就开发了工具,通过爱站的API批量查了网站的SEO数据。还好API调取的价格合理,没花多少钱。

(1007个网站的百度权重分布图)

(如有需要,可以加我的微信或者加入我的知识星球)

通过数据可以发现了几个特征:

第四步,判断所有 hao123推荐链接的友情链接站的程序是否是DZ,是否可以正常打开等

通过上一步的筛选,挖掘到百度权重1~8的网站数量489个;进一步判断网站是否为论坛,是否可以发帖。

工具的基本思路是:

程序分析后发现206个DZ论坛。

(如有需要,可以加我的微信或者加入我的知识星球)

第五步:监测是否可以发外链

这一步程序化存在很大问题,每个论坛的模板不同,首页展示方式不同,很难程序判断。只能人工。

人工检测方式如下:

总结:这次共查到有效DZ论坛206个, 目前查了50多个,发现其他人发外链痕迹的网站有10多个。还算不错。

目前程序还在进行二次开发;会把挖掘高权重论坛进行高度程序化,挖掘更多优质的可以发外链的DZ论坛。后期会在我的博客和公众号公布。

如果需要这次的数据,可以加我的微信或者加入我的免费知识星球获取:

研究搜索引擎原理、用数据说话,不做经验派 查看全部

【外链建设】测试了1500个hao123推荐的网站,只为挖掘发能外链的DZ论坛

点击上面“蓝字”关注!

虽然已经过了外链为皇的时代,但外链在新站建设、重点关键词排名等工作场景中依然占据着很重要的位置。

因为我工作后,大部分的时间在做品牌SEO,没有积攒什么外链资源;这次要梳理SEO技术,我的新博客也需要扩大外链的广泛度。所以前期会在积累外链资源先发力一些。

首先说下为什么从hao123上找外链!网络上的网址千千万,搜索引擎蜘蛛抓取网络中的内容总要有个起点,这个起点就叫“种子站点”。hao123这类网站就是优质的种子站点。关于种子站点的具体含义,可以参考《走进搜索引擎》。

目前论坛外链作用不大,而且很多论坛已经不能发了,这次只是做一个初步尝试。后续会开拓更多类型平台中的外链资源,如目录站点、b2b网站外链等,也会逐步分析我挖掘外链资源的方法和外链建设的策略。

第一步,获取所有hao123推荐链接

hao123论坛推荐页面:

获取本页面所有的网站,共发现212个。

(如有需要,可以加我的微信或者加入我的知识星球)

第二步,获取所有hao123推荐链接的友情链接,0层,1层

利用上一步获得的212个网站,批量查询所有网站的友情链接,并保存。

本次共获得网站数量1452个,平均每个网站的外链数量是:6.8个。过程中,发现很多网站已经不能访问,只能删除;还有大量网站是同一个域名出现多个二、三级域名。也只能通过程序删除,最终剩下1007个站点。提取根域名的方法还比较麻烦,感兴趣的可以看这里python提取根域名(博客中查看)。

第三部:检查网站SEO数据

本来第三步打算开始检测是否是DZ程序的,但后面发现很多网站的权重已经是0了,根本没有挖掘意义,就开发了工具,通过爱站的API批量查了网站的SEO数据。还好API调取的价格合理,没花多少钱。

(1007个网站的百度权重分布图)

(如有需要,可以加我的微信或者加入我的知识星球)

通过数据可以发现了几个特征:

第四步,判断所有 hao123推荐链接的友情链接站的程序是否是DZ,是否可以正常打开等

通过上一步的筛选,挖掘到百度权重1~8的网站数量489个;进一步判断网站是否为论坛,是否可以发帖。

工具的基本思路是:

程序分析后发现206个DZ论坛。

(如有需要,可以加我的微信或者加入我的知识星球)

第五步:监测是否可以发外链

这一步程序化存在很大问题,每个论坛的模板不同,首页展示方式不同,很难程序判断。只能人工。

人工检测方式如下:

总结:这次共查到有效DZ论坛206个, 目前查了50多个,发现其他人发外链痕迹的网站有10多个。还算不错。

目前程序还在进行二次开发;会把挖掘高权重论坛进行高度程序化,挖掘更多优质的可以发外链的DZ论坛。后期会在我的博客和公众号公布。

如果需要这次的数据,可以加我的微信或者加入我的免费知识星球获取:

研究搜索引擎原理、用数据说话,不做经验派

php抓取网页域名这个网站是免费的,服务器一年一交

网站优化 • 优采云 发表了文章 • 0 个评论 • 77 次浏览 • 2022-06-18 10:02

php抓取网页域名这个网站是免费的,免费的意思是域名免费,服务器一年一交。工具是phpstorm环境搭建:1.首先进入网站:/2.修改浏览器:443http代理以为qq号:443就像这样:3.进入浏览器,工具栏选phpstorm4.鼠标右键项目目录下的main.php,不要在目录中!不要在目录中!不要在目录中!5.输入命令行:phpexecl;//可以输入任何前缀都可以,不要在命令行输入前缀(括号中的路径)6.代码完成后,会生成phpstorm.conf文件这样就可以通过phpstorm导入了。

看视频,读书是为了去理解,

我觉得知乎不太适合提问,更适合分享,目前的我走过了想去知乎学习或者去百度搜索相关问题的整个过程,这是我接触到知乎的第一步,现在我对知乎产生了依赖,

看视频,看php教程,

看视频,看电子书,百度php贴吧或者相关论坛(博客,社区)。

手机备忘录做笔记啊。写下遇到的问题的解决办法。

理论好,学起来容易很多,真正掌握php有点难,必须刷题,然后多敲。

既然已经学会php了,应该了解,网页的加载原理了吧,w3c在这方面有太多的资料了,简单说就是让页面加载一些数据或者服务,等数据读取完了把这些加载后的数据,转换成我们需要的动态的东西。数据编码。等等等等。不管你后端的处理多牛逼,服务器的处理多牛逼,php很难实现对所有的后端数据展示逻辑的灵活处理。 查看全部

php抓取网页域名这个网站是免费的,服务器一年一交

php抓取网页域名这个网站是免费的,免费的意思是域名免费,服务器一年一交。工具是phpstorm环境搭建:1.首先进入网站:/2.修改浏览器:443http代理以为qq号:443就像这样:3.进入浏览器,工具栏选phpstorm4.鼠标右键项目目录下的main.php,不要在目录中!不要在目录中!不要在目录中!5.输入命令行:phpexecl;//可以输入任何前缀都可以,不要在命令行输入前缀(括号中的路径)6.代码完成后,会生成phpstorm.conf文件这样就可以通过phpstorm导入了。

看视频,读书是为了去理解,

我觉得知乎不太适合提问,更适合分享,目前的我走过了想去知乎学习或者去百度搜索相关问题的整个过程,这是我接触到知乎的第一步,现在我对知乎产生了依赖,

看视频,看php教程,

看视频,看电子书,百度php贴吧或者相关论坛(博客,社区)。

手机备忘录做笔记啊。写下遇到的问题的解决办法。

理论好,学起来容易很多,真正掌握php有点难,必须刷题,然后多敲。

既然已经学会php了,应该了解,网页的加载原理了吧,w3c在这方面有太多的资料了,简单说就是让页面加载一些数据或者服务,等数据读取完了把这些加载后的数据,转换成我们需要的动态的东西。数据编码。等等等等。不管你后端的处理多牛逼,服务器的处理多牛逼,php很难实现对所有的后端数据展示逻辑的灵活处理。

用phpmyadmin插件安装web.url抓取的具体步骤:抓取

网站优化 • 优采云 发表了文章 • 0 个评论 • 123 次浏览 • 2022-06-16 12:01

php抓取网页域名:

1、用phpmyadmin插件安装

2、在phpmyadmin中创建账户名admin,绑定域名,然后登录域名,查看工作目录。

下面讲解phpmyadmin抓取的具体步骤:

1、用username命令设置用户名setusername@'%'web.name"solarfield"

2、用admin命令修改用户密码setadmin@'%'adminsetpassword@'%'web.name"solarfield"

3、修改首次登录的邮箱账号和密码set@'%'@'%'@'%'web.email"solarfield"

5、修改登录后次次登录的域名set@'%'@'%'@'%'web.url"solarfield"web.name"solarfield"

用c/c++重新实现下最简单的curl命令行抓取的功能,

现在phpstorm中一步一步填下去试下吧

仔细阅读后面的代码就会发现,

呃,

有点儿类似:看renfifo

可以试试在web服务器中执行phphttpformaction

讲讲自己的方案:通过参数获取,就是你服务器出来那一步。

用webm, 查看全部

用phpmyadmin插件安装web.url抓取的具体步骤:抓取

php抓取网页域名:

1、用phpmyadmin插件安装

2、在phpmyadmin中创建账户名admin,绑定域名,然后登录域名,查看工作目录。

下面讲解phpmyadmin抓取的具体步骤:

1、用username命令设置用户名setusername@'%'web.name"solarfield"

2、用admin命令修改用户密码setadmin@'%'adminsetpassword@'%'web.name"solarfield"

3、修改首次登录的邮箱账号和密码set@'%'@'%'@'%'web.email"solarfield"

5、修改登录后次次登录的域名set@'%'@'%'@'%'web.url"solarfield"web.name"solarfield"

用c/c++重新实现下最简单的curl命令行抓取的功能,

现在phpstorm中一步一步填下去试下吧

仔细阅读后面的代码就会发现,

呃,

有点儿类似:看renfifo

可以试试在web服务器中执行phphttpformaction

讲讲自己的方案:通过参数获取,就是你服务器出来那一步。

用webm,

php抓取网页域名url通过定制ga测试网页质量比较高

网站优化 • 优采云 发表了文章 • 0 个评论 • 108 次浏览 • 2022-06-05 03:01

php抓取网页域名url通过定制ga测试网页质量.将谷歌等浏览器插件,安装到php里面,通过发送ga到服务器检测哪个页面质量比较高,最好通过定制安装脚本来进行执行,最后结果通过服务器中间人注入js脚本php抓取页面数据并且进行数据处理

先看php网站权重是多少:看页面的权重是通过什么方式计算出来的,可以查看自己网站的历史数据,看权重的计算方式是怎么样的,还有自己的网站每月换ip次数、注册用户次数、pv次数等,

主要是通过页面ip访问的数量和pv访问的数量来预估的吧

看页面权重?什么页面权重?你就把他写在脚本里面去调试就好了,通过数量和pv做一些大概的比对

从这个页面开始

seo分析应该是最基础的seo吧,权重的反向问题就不知道怎么回答了。

1是权重2如果你能搜到我

1是pv2请抓取我的页面并查看数据

//楼主可以试试ga/tag=“ga”或者说点击/trait=click/trait=action/trait=location/trait=recipient/s=1/

如果你明确知道一个url访问了多少次,就能大概算出一个页面的总权重,简单的说是页面的metadescription就好。但是如果你记录了这个页面的所有信息,比如首页是做什么的,这个页面是什么链接搭建的,每页跳转多少次,大概一页就有多少次点击,这样一个页面不管是url还是pv其实都是变化的,就好像一个新建的网站和在线的网站一样。

这个时候,url=/android/?android=1,pv不过1,等等。ps:虽然没见过这么算。 查看全部

php抓取网页域名url通过定制ga测试网页质量比较高

php抓取网页域名url通过定制ga测试网页质量.将谷歌等浏览器插件,安装到php里面,通过发送ga到服务器检测哪个页面质量比较高,最好通过定制安装脚本来进行执行,最后结果通过服务器中间人注入js脚本php抓取页面数据并且进行数据处理

先看php网站权重是多少:看页面的权重是通过什么方式计算出来的,可以查看自己网站的历史数据,看权重的计算方式是怎么样的,还有自己的网站每月换ip次数、注册用户次数、pv次数等,

主要是通过页面ip访问的数量和pv访问的数量来预估的吧

看页面权重?什么页面权重?你就把他写在脚本里面去调试就好了,通过数量和pv做一些大概的比对

从这个页面开始

seo分析应该是最基础的seo吧,权重的反向问题就不知道怎么回答了。

1是权重2如果你能搜到我

1是pv2请抓取我的页面并查看数据

//楼主可以试试ga/tag=“ga”或者说点击/trait=click/trait=action/trait=location/trait=recipient/s=1/

如果你明确知道一个url访问了多少次,就能大概算出一个页面的总权重,简单的说是页面的metadescription就好。但是如果你记录了这个页面的所有信息,比如首页是做什么的,这个页面是什么链接搭建的,每页跳转多少次,大概一页就有多少次点击,这样一个页面不管是url还是pv其实都是变化的,就好像一个新建的网站和在线的网站一样。

这个时候,url=/android/?android=1,pv不过1,等等。ps:虽然没见过这么算。

德语2101班级网站镜像部署上线啦!

网站优化 • 优采云 发表了文章 • 0 个评论 • 99 次浏览 • 2022-05-13 14:39

为更好促进外语学习需要,德语2101班已于近日部署完成了部分网站镜像,供各位同学学习与参考。

- 01 -

使用指南

镜像网站可以在上方的导航栏内Mirror栏直达,也可以直接输入/mirror/mirror.html直接进入(手机端推荐此方法),在本公众号内还可以通过阅读原文链接访问。

目前根据我班实际需要部署了中文、英语、德语三种语言的百科内容。本镜像网站的优点在于:无需任何配置,直接使用普通浏览器连接,且访问速度远远快于普通的全局代理模式。用户仅需点击蓝色链接,即可实现对于以上网站的访问。

- 02 -

注意事项(重要!!!)

在使用镜像网站前,您必须充分阅读以下注意事项,并充分理解并声明愿意遵守:

Google镜像仅能访问Google搜索和Google图片,其余Google旗下服务如YouTube、Gmail、Google Drive等暂不支持;

支持终端(Supported Terminal)中显示PC, Portable的,表明其适配了电脑及移动端,手机、电脑浏览器均可直接访问;如仅有PC端,在手机端访问时,可以将手机浏览器的UI(一般在选项或者设置中)调成“电脑模式”或者”桌面端“即可访问;

本镜像网站仅限校内使用,请勿将本页面任何内容、域名、IP地址在任何公网上进行传播!

Google镜像使用单独服务器,三个Wikipedia镜像共用一个服务器,每个服务器瞬时带宽为2TB,为了服务器正常运行,不建议同时上线人数大于25;

服务器已经开启监视器功能,请勿使用本网站从事瞬时、大容量下载,或者爬虫、反向代理等行为,对于明显带宽异常的IP我们会将整个IP段进行封禁;

后期我们将编写使用及维护手册,在2022年5月31日前为试运行阶段,试运行期间不保证服务器的稳定性,可能遭遇停机、重置或者IP更改等问题;

本网站不能抓取您在镜像中输入的任何内容,仅承担中继功能,但同时您也需要注意您是否愿意将您的数据共享给Google LLC,Wikimedia org;

多个域名可能共用同一个IP,因此请不要使用IP地址访问;

- 03 -

我想短暂使用其他受限制网站

您可以通过私信的方式私信网站运营者,并注明使用时间及用途。我们将对服务器进行配置,并允许特定IP在一段时间内的访问。

本服务使用nginx + PHP,cURL,Apache,Node.js在Linux CentOS 7环境下编译完成,部分网页支持Let's Encrypt SSL证书配置,支持PHP 7.x,CentOS7.x 8.x编译环境 查看全部

德语2101班级网站镜像部署上线啦!

为更好促进外语学习需要,德语2101班已于近日部署完成了部分网站镜像,供各位同学学习与参考。

- 01 -

使用指南

镜像网站可以在上方的导航栏内Mirror栏直达,也可以直接输入/mirror/mirror.html直接进入(手机端推荐此方法),在本公众号内还可以通过阅读原文链接访问。

目前根据我班实际需要部署了中文、英语、德语三种语言的百科内容。本镜像网站的优点在于:无需任何配置,直接使用普通浏览器连接,且访问速度远远快于普通的全局代理模式。用户仅需点击蓝色链接,即可实现对于以上网站的访问。

- 02 -

注意事项(重要!!!)

在使用镜像网站前,您必须充分阅读以下注意事项,并充分理解并声明愿意遵守:

Google镜像仅能访问Google搜索和Google图片,其余Google旗下服务如YouTube、Gmail、Google Drive等暂不支持;

支持终端(Supported Terminal)中显示PC, Portable的,表明其适配了电脑及移动端,手机、电脑浏览器均可直接访问;如仅有PC端,在手机端访问时,可以将手机浏览器的UI(一般在选项或者设置中)调成“电脑模式”或者”桌面端“即可访问;

本镜像网站仅限校内使用,请勿将本页面任何内容、域名、IP地址在任何公网上进行传播!

Google镜像使用单独服务器,三个Wikipedia镜像共用一个服务器,每个服务器瞬时带宽为2TB,为了服务器正常运行,不建议同时上线人数大于25;

服务器已经开启监视器功能,请勿使用本网站从事瞬时、大容量下载,或者爬虫、反向代理等行为,对于明显带宽异常的IP我们会将整个IP段进行封禁;

后期我们将编写使用及维护手册,在2022年5月31日前为试运行阶段,试运行期间不保证服务器的稳定性,可能遭遇停机、重置或者IP更改等问题;

本网站不能抓取您在镜像中输入的任何内容,仅承担中继功能,但同时您也需要注意您是否愿意将您的数据共享给Google LLC,Wikimedia org;

多个域名可能共用同一个IP,因此请不要使用IP地址访问;

- 03 -

我想短暂使用其他受限制网站

您可以通过私信的方式私信网站运营者,并注明使用时间及用途。我们将对服务器进行配置,并允许特定IP在一段时间内的访问。

本服务使用nginx + PHP,cURL,Apache,Node.js在Linux CentOS 7环境下编译完成,部分网页支持Let's Encrypt SSL证书配置,支持PHP 7.x,CentOS7.x 8.x编译环境

php抓取网页域名 轻松玩转SEO,看这篇就够了

网站优化 • 优采云 发表了文章 • 0 个评论 • 113 次浏览 • 2022-05-09 07:37

欢迎投稿到早读课,投稿邮箱:

最近在看SEO方面的知识,很是有趣,能学些新东西的感觉总是好的,随着经历增多心境较之前也少了些浮躁,当下的年纪也正是钻研些好玩事物的大好时光,在这里给大家推荐两本SEO的基础入门书籍,《百度SEO一本通》 《7天精通SEO》希望借此文和志同道合者共同进步!

虽然现在最火的SEO书籍是Zac出的那本《SEO实战密码》,豆瓣评分也不错,但实际读来逻辑比较散乱,信息量太大,有点像历史博客文章的堆积,对于刚接触SEO的人来说其实并不适合,个人建议可以先从入门的书籍开始看,形成自己的理解体系,然后再用自己建立起来的这套体系去做加深阅读,这也是我常用的方法,实际说来我看书的量并不多,更偏向看适合自己这个阶段的,去到书中参悟。

首先,让我们先来看看这两本书的逻辑体系,带着方向去阅读

《7天精通SEO》.png

这书本重点看站内篇、站外篇、策略篇部分,这三个部分主要讲做优化的实际方法论,基础篇就是了解大致常识,可以快速浏览,可以和案例篇专题篇组合来看。

《百度SEO一本通》.png

这本书主要看关键词、链接优化技巧,理解和了解网络技术和百度的竞价推广、网盟推广。

接下来,梳理下SEO的基本常识(不完全的部分会在后续补充)

1. SEO定义:

Search Engine Optimization(全称)也即搜索引擎优化,就是从搜索引擎上获得流量的技术。搜索引擎的主要工作包括:通过了解搜索引擎的工作原理掌握如何在网页流中爬取网页、如何进行索引以及如何确定某一关键词排名位置从而对网页内容进行科学的优化,使其符合用户浏览习惯的同时提高排名与网站访问量,最终获得商业化能力的技术。

2. 搜索引擎工作原理:

主要有三段工作流程:爬行抓取、预处理、服务输出

2.1 爬行抓取

主要功能是对网页进行抓取,目前有三种爬行抓取方法

2.1.1 常见蜘蛛

搜索引擎蜘蛛是搜索引擎的一个自动程序,作用是访问互联网上的网页、图片、视频等内容,建立索引库,一般用法为spider+URL这里的URL是搜索引擎的痕迹,可以通过查看服务器里的日志里是否有该URL,同时还能查看一些列属性。

2.1.2 爬行策略

2.1.3 预处理

也即对抓取回来的数据进行一个索引工作,其中包括多个流程,在后台提前完成。

2.1.3.1 关键词提取

将HTML、JS、CSS等标签&程序去除,提取用于排名的有效文字。

2.1.3.2去除停用词

即反复出现的无用词,如:“得、的、地、啊、阿、再”等

2.1.3.3分词技术

是中文搜索引擎特有的技术支持,中文不同于英文单词与单词之间用空格分隔,因此搜索引擎必须把整个句子切割成小单元词,分词的方法有两种

2.1.3.4消除噪声

消除网页上各种广告文字、图片、登录框、版权信息等对搜索引擎无用的东西。

2.1.3.5分析网页建立倒排文件

![Upload 索引.jpg failed. Please try again.]

2.1.3.6 链接关系计算

计算出页面上有哪些链接指向哪些其他页面,每个页面有哪些导入链接,链接使用了什么锚文本等,Google推出的PR是代表之一。

2.1.3.7 特殊文件处理

对flash、视频、PPT、XLS、图片等非文字内容不能执行脚本和程序。图片一般使用标签

2.2 服务输出

输出结果的展现方式,如:与搜索关键词匹配的部分用红色字体标出

输出

3. 网站分类目录

是人为编辑的搜索结果,将互联网上优秀的网站收集整理在一起,按照不同的分类或者主题放在相应的目录中,多靠人为提交,如:hao123网址导航

4. 关键词

一般指用户在搜索框中自定义输入的信息,按照概念可以分为:目标关键词、长尾关键词、相关关键词;按页面上分,可以为首页、栏目页、内容页关键词;按目的来分可以分为直接性、营销性关键词

5. 权重和PR值(PageRank)

PR值是谷歌搜索引擎用来衡量网页重要性的一种方法,也是其判断一个网站好坏的重要标准之一,最大的影响因素为是否拥有大量的高质量外链。

网站权重是指网站与网站在搜索引擎眼中的分级制“待遇”表现,是搜索引擎中的一个综合表现指标,决定因素有:外部链接的导入、稳定的高质量内容和结构清晰的网站结构等。

要注意区分这是两个不同的概念

6. 白帽SEO和黑帽SEO

7. 锚文本、外链、内链、单向链接、双向链接、导出链接、导入链接

8. 有机列表

是SERP中的免费列表,即搜索结果页面的免费列表,可以通过制定SEO策略进行优化。

9. robots.txt文件

Robots Exclusion Protocol,网站通过Robots协议告诉搜索引擎哪些页面可以抓取,哪些页面不能抓取。多用来避免出现大量404页面、死链接如何查看?格式:在浏览器中输入URL/robots.txt即可,下面是

![Uploading d62a6059252dd42a8d159f41013b5bb5c9eab838_722675.jpg . . .]文件

User-agent: Baiduspider

Disallow: /

User-agent: baiduspider

Disallow: /

User agent 指浏览器

robots文件常通过组合的方式来运用,主要有如下四种情况

10. nofollow

决定是否对网站进行投票,传递权重,可以用来防止垃圾链接

11. 黑链

只存在于源代码中的超链接

12.动态网址和静态网址

13.搜索跳出率

用户查到一个网站并点击进入,且只浏览了一个页面就离开所占的比例

14. 网页快照

搜索引擎在收录网页时,对网页进行备份,存在自己的服务器缓存里,当用户在搜索引擎中点击“网页快照”链接时,搜索引擎将Spider系统当时所抓取并保存的网页内容展现出来,称为“网页快照”。 查看全部

php抓取网页域名 轻松玩转SEO,看这篇就够了

欢迎投稿到早读课,投稿邮箱:

最近在看SEO方面的知识,很是有趣,能学些新东西的感觉总是好的,随着经历增多心境较之前也少了些浮躁,当下的年纪也正是钻研些好玩事物的大好时光,在这里给大家推荐两本SEO的基础入门书籍,《百度SEO一本通》 《7天精通SEO》希望借此文和志同道合者共同进步!

虽然现在最火的SEO书籍是Zac出的那本《SEO实战密码》,豆瓣评分也不错,但实际读来逻辑比较散乱,信息量太大,有点像历史博客文章的堆积,对于刚接触SEO的人来说其实并不适合,个人建议可以先从入门的书籍开始看,形成自己的理解体系,然后再用自己建立起来的这套体系去做加深阅读,这也是我常用的方法,实际说来我看书的量并不多,更偏向看适合自己这个阶段的,去到书中参悟。

首先,让我们先来看看这两本书的逻辑体系,带着方向去阅读

《7天精通SEO》.png

这书本重点看站内篇、站外篇、策略篇部分,这三个部分主要讲做优化的实际方法论,基础篇就是了解大致常识,可以快速浏览,可以和案例篇专题篇组合来看。

《百度SEO一本通》.png

这本书主要看关键词、链接优化技巧,理解和了解网络技术和百度的竞价推广、网盟推广。

接下来,梳理下SEO的基本常识(不完全的部分会在后续补充)

1. SEO定义:

Search Engine Optimization(全称)也即搜索引擎优化,就是从搜索引擎上获得流量的技术。搜索引擎的主要工作包括:通过了解搜索引擎的工作原理掌握如何在网页流中爬取网页、如何进行索引以及如何确定某一关键词排名位置从而对网页内容进行科学的优化,使其符合用户浏览习惯的同时提高排名与网站访问量,最终获得商业化能力的技术。

2. 搜索引擎工作原理:

主要有三段工作流程:爬行抓取、预处理、服务输出

2.1 爬行抓取

主要功能是对网页进行抓取,目前有三种爬行抓取方法

2.1.1 常见蜘蛛

搜索引擎蜘蛛是搜索引擎的一个自动程序,作用是访问互联网上的网页、图片、视频等内容,建立索引库,一般用法为spider+URL这里的URL是搜索引擎的痕迹,可以通过查看服务器里的日志里是否有该URL,同时还能查看一些列属性。

2.1.2 爬行策略

2.1.3 预处理

也即对抓取回来的数据进行一个索引工作,其中包括多个流程,在后台提前完成。

2.1.3.1 关键词提取

将HTML、JS、CSS等标签&程序去除,提取用于排名的有效文字。

2.1.3.2去除停用词

即反复出现的无用词,如:“得、的、地、啊、阿、再”等

2.1.3.3分词技术

是中文搜索引擎特有的技术支持,中文不同于英文单词与单词之间用空格分隔,因此搜索引擎必须把整个句子切割成小单元词,分词的方法有两种

2.1.3.4消除噪声

消除网页上各种广告文字、图片、登录框、版权信息等对搜索引擎无用的东西。

2.1.3.5分析网页建立倒排文件

![Upload 索引.jpg failed. Please try again.]

2.1.3.6 链接关系计算

计算出页面上有哪些链接指向哪些其他页面,每个页面有哪些导入链接,链接使用了什么锚文本等,Google推出的PR是代表之一。

2.1.3.7 特殊文件处理

对flash、视频、PPT、XLS、图片等非文字内容不能执行脚本和程序。图片一般使用标签

2.2 服务输出

输出结果的展现方式,如:与搜索关键词匹配的部分用红色字体标出

输出

3. 网站分类目录

是人为编辑的搜索结果,将互联网上优秀的网站收集整理在一起,按照不同的分类或者主题放在相应的目录中,多靠人为提交,如:hao123网址导航

4. 关键词

一般指用户在搜索框中自定义输入的信息,按照概念可以分为:目标关键词、长尾关键词、相关关键词;按页面上分,可以为首页、栏目页、内容页关键词;按目的来分可以分为直接性、营销性关键词

5. 权重和PR值(PageRank)

PR值是谷歌搜索引擎用来衡量网页重要性的一种方法,也是其判断一个网站好坏的重要标准之一,最大的影响因素为是否拥有大量的高质量外链。

网站权重是指网站与网站在搜索引擎眼中的分级制“待遇”表现,是搜索引擎中的一个综合表现指标,决定因素有:外部链接的导入、稳定的高质量内容和结构清晰的网站结构等。

要注意区分这是两个不同的概念

6. 白帽SEO和黑帽SEO

7. 锚文本、外链、内链、单向链接、双向链接、导出链接、导入链接

8. 有机列表

是SERP中的免费列表,即搜索结果页面的免费列表,可以通过制定SEO策略进行优化。

9. robots.txt文件

Robots Exclusion Protocol,网站通过Robots协议告诉搜索引擎哪些页面可以抓取,哪些页面不能抓取。多用来避免出现大量404页面、死链接如何查看?格式:在浏览器中输入URL/robots.txt即可,下面是

![Uploading d62a6059252dd42a8d159f41013b5bb5c9eab838_722675.jpg . . .]文件

User-agent: Baiduspider

Disallow: /

User-agent: baiduspider

Disallow: /

User agent 指浏览器

robots文件常通过组合的方式来运用,主要有如下四种情况

10. nofollow

决定是否对网站进行投票,传递权重,可以用来防止垃圾链接

11. 黑链

只存在于源代码中的超链接

12.动态网址和静态网址

13.搜索跳出率

用户查到一个网站并点击进入,且只浏览了一个页面就离开所占的比例

14. 网页快照

搜索引擎在收录网页时,对网页进行备份,存在自己的服务器缓存里,当用户在搜索引擎中点击“网页快照”链接时,搜索引擎将Spider系统当时所抓取并保存的网页内容展现出来,称为“网页快照”。

php抓取网页域名 网站设计的几个步骤你了解吗(怎样做出吸引人的网站)

网站优化 • 优采云 发表了文章 • 0 个评论 • 163 次浏览 • 2022-05-07 02:25

随着网站应用率增加,因此,有不少的网站设计公司推出各种便捷的网站制作工具,使用也比较方便,所以网页制作成了一件很容易的事,几年前,没有一定的网站建设基础知识,无法用手写代码设计网页。

正因为这样,才会有很多的人认为网页制作很简单,所以他们急于制作自己的网站,但他们发现自己的网站却很粗糙,要想做好网站,必须要知道设计一个网站的步骤,网站设计的八个步骤,你知道吗?今天来讲讲网站设计步骤。

一、网站主题风格

不管是什么类型的企业网站还是个人网站都应该确定主题及风格。

网站的主题是你建立网站包含了哪些内容,找到用户感兴趣的内容,再深入、彻底挖掘出自己的特点,网站的主题风格并不固定,什么内容都可以,着重点突出主题,要把内容做大、做得细,还要统一网站的风格、用色、用图,以便给用户留下深刻的印象。

二、搜集整理材料

确定好网站的主题以后,你就要围绕主题开始搜集网站所需要的资料。

要想让自己的网站有特色,能够吸引住用户的眼球,你就要多搜集整理一些有价值的材料,这样以后制作网站就容易些。

什么地方可以搜集资料,资料可从书籍、报纸、光盘、多媒体、网上收集并整理,将收集到的材料去粗、去伪,作为自己网页的素材。

三、规划策划网站

网站设计的好与坏取决于设计师的策划水平,网站规划的内容主要所包含了网站结构、栏目设计、主题风格、色彩搭配、版面布局、文案整理以及图片的使用,在做网页前要充分考虑到这几个方面,才能在制作过程中做到心中有数。

只有这样,网页设计才能有个性、特色和吸引力。

四、开始设计网站

选择自己擅长的制作工具,常用的网页制作工具有firework、Photoshop,动画制作软件有Flash,这些软件都可以免费在网上下载。

软件工具选好之后,就开始设计网站了。

在设计网站时,先将大体结构设计好,然后逐渐完善细节,从设计开始,先设计简单的内容,再设计复杂的内容,以便有问题时好修改。

五、制作网页后台

完成了网站页面设计,再将网站平面图进行切图,在使用Dreamweaver制作网页,包含了可视化编辑、HTML代码编辑、以及ActiveX、JavaScript、Java、Flash、Shockwave等功能,生成动态HTML。

完成前端html页面,要灵活管理网站的内容,提高工作效率,就需要一个后台管理系统,目前使用率比较的网站开发语言是PHP,数据类型为Mysql,网上有很多好用的开源系统。

六、上传到Web

页面制作、后台功能开发完成后,再将全部文件及数据库发布到Web服务器上,也就是我们买的虚拟主机,做好域名解析批向并在空间上绑定域名,用户就可以通过游览器看网站了,上传数据工具有LeapFTP、FlashFXP软件,就可以很方便的将网站所有内容发布到网络上。

七、网站宣传推广

网站设计制作完成后,要进行全网宣传,以提高网站的访问率和知名度,增加网站流量的同时,带来更多的咨询客户。

网站推广的方式有很多,比如搜索引擎提交、自媒体、分类信息、交换链接、添加广告链接等。

八、维护更新内容

网站能不能持续留住用户,让搜索引擎时时关注,网站就要经常更新原创有价值的内容,随时保持内容新鲜,只有不断更新内容,才能吸引用户来浏览网站,让蜘蛛抓取内容,给网站有排名的机会。

查看全部

php抓取网页域名 网站设计的几个步骤你了解吗(怎样做出吸引人的网站)

随着网站应用率增加,因此,有不少的网站设计公司推出各种便捷的网站制作工具,使用也比较方便,所以网页制作成了一件很容易的事,几年前,没有一定的网站建设基础知识,无法用手写代码设计网页。

正因为这样,才会有很多的人认为网页制作很简单,所以他们急于制作自己的网站,但他们发现自己的网站却很粗糙,要想做好网站,必须要知道设计一个网站的步骤,网站设计的八个步骤,你知道吗?今天来讲讲网站设计步骤。

一、网站主题风格

不管是什么类型的企业网站还是个人网站都应该确定主题及风格。

网站的主题是你建立网站包含了哪些内容,找到用户感兴趣的内容,再深入、彻底挖掘出自己的特点,网站的主题风格并不固定,什么内容都可以,着重点突出主题,要把内容做大、做得细,还要统一网站的风格、用色、用图,以便给用户留下深刻的印象。

二、搜集整理材料

确定好网站的主题以后,你就要围绕主题开始搜集网站所需要的资料。

要想让自己的网站有特色,能够吸引住用户的眼球,你就要多搜集整理一些有价值的材料,这样以后制作网站就容易些。

什么地方可以搜集资料,资料可从书籍、报纸、光盘、多媒体、网上收集并整理,将收集到的材料去粗、去伪,作为自己网页的素材。

三、规划策划网站

网站设计的好与坏取决于设计师的策划水平,网站规划的内容主要所包含了网站结构、栏目设计、主题风格、色彩搭配、版面布局、文案整理以及图片的使用,在做网页前要充分考虑到这几个方面,才能在制作过程中做到心中有数。

只有这样,网页设计才能有个性、特色和吸引力。

四、开始设计网站

选择自己擅长的制作工具,常用的网页制作工具有firework、Photoshop,动画制作软件有Flash,这些软件都可以免费在网上下载。

软件工具选好之后,就开始设计网站了。

在设计网站时,先将大体结构设计好,然后逐渐完善细节,从设计开始,先设计简单的内容,再设计复杂的内容,以便有问题时好修改。

五、制作网页后台

完成了网站页面设计,再将网站平面图进行切图,在使用Dreamweaver制作网页,包含了可视化编辑、HTML代码编辑、以及ActiveX、JavaScript、Java、Flash、Shockwave等功能,生成动态HTML。

完成前端html页面,要灵活管理网站的内容,提高工作效率,就需要一个后台管理系统,目前使用率比较的网站开发语言是PHP,数据类型为Mysql,网上有很多好用的开源系统。

六、上传到Web

页面制作、后台功能开发完成后,再将全部文件及数据库发布到Web服务器上,也就是我们买的虚拟主机,做好域名解析批向并在空间上绑定域名,用户就可以通过游览器看网站了,上传数据工具有LeapFTP、FlashFXP软件,就可以很方便的将网站所有内容发布到网络上。

七、网站宣传推广

网站设计制作完成后,要进行全网宣传,以提高网站的访问率和知名度,增加网站流量的同时,带来更多的咨询客户。

网站推广的方式有很多,比如搜索引擎提交、自媒体、分类信息、交换链接、添加广告链接等。

八、维护更新内容

网站能不能持续留住用户,让搜索引擎时时关注,网站就要经常更新原创有价值的内容,随时保持内容新鲜,只有不断更新内容,才能吸引用户来浏览网站,让蜘蛛抓取内容,给网站有排名的机会。

php抓取网页域名(获取客户端真正方法.使用php获取IP的方法能找到)

网站优化 • 优采云 发表了文章 • 0 个评论 • 90 次浏览 • 2022-04-19 22:10

我最近在做的一个项目使用了获取域名和IP的功能。大致有以下几种方法。

获取域名IP的方法可以使用内置函数gethostbyname来获取,例如:

echo gethostbyname("www.jbxue.com");

上面会直接输出域名对应的IP。当然不同地方的测试结果是不一样的,因为百度服务器不止一台,我这边的ip是115.239.210.27;

下面是获取域名的方法,比如有这样一个URL:

//则会输出www.jbxue.com

//全局数组

echo $_SERVER[“HTTP_HOST”];

如果我在本地测试,它将输出 localhost

第二种获取域名的方法是使用:parse_url函数;

$url ="http://www.jbxue.com/index.php ... 3B%3B

$arr=parse_url($url);

echo "

";

print_r($arr);

echo "

“;

这段代码得到一个数组,当我们打印这个数组时,你会一目了然;

大批

(

[方案] => http

[主持人] =>

[路径] => /index.php

[查询] => 推荐人=

)

scheme对应协议,host对应域名,path对应执行文件路径,query对应相关参数;

php获取域名信息的第三种方法:

对于同一个域名,我们使用第三种方式获取域名,我们使用自定义函数获取。

$url ="http://www.jbxue.com/index.php ... 3B%3B

get_host($url);

function get_host($url){

//首先替换掉http://

$url=str_replace("http://","",$url);

//获得去掉http://url的/最先出现的位置

$position=strpos($url,"/");

//如果没有斜杠则表明url里面没有参数,直接返回url,

//否则截取字符串

if($position==false){

echo $url;

}else{

echo substr($url,0,$position);

}

}

?>

最后一种方法是使用常规规则。这一步比较复杂。要实现复杂的域名匹配,需要更复杂的正则规则。我只是提供一些想法,大家应该多尝试。

header("Content-type:text/html;charset=utf-8");

$url ="http://www.jbxue.com/index.php ... 3B%3B

$pattern="/(http:\/\/)?(.*)\//";

if(preg_match($pattern,$url,$arr)){

echo "匹配成功";

echo "匹配到了".$arr[2];

}

?>

php获取客户端IP地址的几种方法

阅读php获取客户端IP地址的几种方法,

1:来看看代码:

echo "(1)浏览当前页面的用户的 IP 地址为:";

echo $_SERVER['REMOTE_ADDR'];

echo "";

echo "(2)浏览当前页面的用户的 IP 地址为:";

echo getenv('REMOTE_ADDR');

echo "";

echo "主机 www.baidu.com 的 IP 地址为:";

echo gethostbyname(www.baidu.com);

2:它的输出结果为:

(1)浏览当前页面的用户的 IP 地址为:127.0.0.1

(2)浏览当前页面的用户的 IP 地址为:127.0.0.1

主机 www.baidu.com 的 IP 地址为:61.135.169.105

3:关于获取客户端的 IP 地址,有俩方法:

第一个是使用:

$_SERVER['REMOTE_ADDR']

它正在浏览当前页面用户的 IP 地址,这里的输出结果为 127.0.0.1,因为这是在本地测试,输出的是我本地的环路地址。

第俩个是使用:

getenv('REMOTE_ADDR')

这里使用了函数 getenv : Gets the value of an environment variable(得到各种环境变量的值),返回值:Returns the value of the environment variable varname, or FALSE on an error(失败的话返回 FALSE).

4:关于获取服务器端的 IP 地址:

gethostbyname(www.baidu.com)

这里使用了函数 gethostbyname : Get the IP address corresponding to a given Internet host name(通过给定的一个主机名字而得到它的 IP 地址),返回值:Returns the IP address of the Internet host specified by hostname or a string containing the unmodified hostname on failure(失败的话返回原样的输入字符主机名).

5:注意这里的最后一句,也就是说,如果失败的话,它会将原样输出,

例如:

echo "无效主机 iwilldown 的 IP 地址为:";

echo gethostbyname("iwilldown");

输出无效主机 iwilldown 的 IP 地址为:iwilldown 当然,这个可不是 IP 地址….~~~~

获取客户端IP其实并不是一件简单的事情。由于IP欺骗和代理问题,获取客户端IP的真实性会打折扣,不能100%准确。但我们仍在努力寻找更完善的获客解决方案。终端的真实ip方法。使用php获取IP的方法有很多种。

function getIp(){

if (getenv("HTTP_CLIENT_IP") && strcasecmp(getenv("HTTP_CLIENT_IP"), "unknown"))

$ip = getenv("HTTP_CLIENT_IP");

else if (getenv("HTTP_X_FORWARDED_FOR") && strcasecmp(getenv("HTTP_X_FORWARDED_FOR"), "unknown"))

$ip = getenv("HTTP_X_FORWARDED_FOR");

else if (getenv("REMOTE_ADDR") && strcasecmp(getenv("REMOTE_ADDR"), "unknown"))

$ip = getenv("REMOTE_ADDR");

else if (isset($_SERVER['REMOTE_ADDR']) && $_SERVER['REMOTE_ADDR'] && strcasecmp($_SERVER['REMOTE_ADDR'], "unknown"))

$ip = $_SERVER['REMOTE_ADDR'];

else

$ip = "unknown";

return($ip);

现在我们需要解释这段代码。这里使用了两个函数,getenv() 和 strcasecmp()。前一个函数获取系统的环境变量。如果能获取到值,则返回该值,否则返回false。

$_SERVER 是服务器的超级全局变量数组。您还可以使用 $_SERVER['REMOTE_ADDR'] 来获取客户端的 IP 地址。两者的区别在于getenv不支持php在IIS的isapi模式下运行。

strcasecmp(string1, string2) string函数的用法是比较string1和string2,如果相等,返回0,如果string1大于string2,返回大于0的数,如果小于则返回一个数小于 0。

该函数首先使用客户端IP,如果没有建立尝试使用代理方法,如果没有,则使用REMOTE_ADDR。

我还看到了一种更详细的检测 IP 的方法,考虑到 IP 欺骗和多代理代码。方法类似。

function getip() {

$unknown = 'unknown';

if ( isset($_SERVER['HTTP_X_FORWARDED_FOR']) && $_SERVER['HTTP_X_FORWARDED_FOR'] && strcasecmp($_SERVER['HTTP_X_FORWARDED_FOR'], $unknown) ) {

$ip = $_SERVER['HTTP_X_FORWARDED_FOR'];

} elseif ( isset($_SERVER['REMOTE_ADDR']) && $_SERVER['REMOTE_ADDR'] && strcasecmp($_SERVER['REMOTE_ADDR'], $unknown) ) {

$ip = $_SERVER['REMOTE_ADDR'];

}

/*

处理多层代理的情况

或者使用正则方式:$ip = preg_match("/[\d\.]{7,15}/", $ip, $matches) ? $matches[0] : $unknown;

*/

if (false !== strpos($ip, ','))

$ip = reset(explode(',', $ip));

return $ip;

}

一、不使用代理服务器的PHP获取客户端IP情况:

REMOTE_ADDR= 客户端 IP 查看全部

php抓取网页域名(获取客户端真正方法.使用php获取IP的方法能找到)

我最近在做的一个项目使用了获取域名和IP的功能。大致有以下几种方法。

获取域名IP的方法可以使用内置函数gethostbyname来获取,例如:

echo gethostbyname("www.jbxue.com");

上面会直接输出域名对应的IP。当然不同地方的测试结果是不一样的,因为百度服务器不止一台,我这边的ip是115.239.210.27;

下面是获取域名的方法,比如有这样一个URL:

//则会输出www.jbxue.com

//全局数组

echo $_SERVER[“HTTP_HOST”];

如果我在本地测试,它将输出 localhost

第二种获取域名的方法是使用:parse_url函数;

$url ="http://www.jbxue.com/index.php ... 3B%3B

$arr=parse_url($url);

echo "

";

print_r($arr);

echo "

“;

这段代码得到一个数组,当我们打印这个数组时,你会一目了然;

大批

(

[方案] => http

[主持人] =>

[路径] => /index.php

[查询] => 推荐人=

)

scheme对应协议,host对应域名,path对应执行文件路径,query对应相关参数;

php获取域名信息的第三种方法:

对于同一个域名,我们使用第三种方式获取域名,我们使用自定义函数获取。

$url ="http://www.jbxue.com/index.php ... 3B%3B

get_host($url);

function get_host($url){

//首先替换掉http://

$url=str_replace("http://","",$url);

//获得去掉http://url的/最先出现的位置

$position=strpos($url,"/");

//如果没有斜杠则表明url里面没有参数,直接返回url,

//否则截取字符串

if($position==false){

echo $url;

}else{

echo substr($url,0,$position);

}

}

?>

最后一种方法是使用常规规则。这一步比较复杂。要实现复杂的域名匹配,需要更复杂的正则规则。我只是提供一些想法,大家应该多尝试。

header("Content-type:text/html;charset=utf-8");

$url ="http://www.jbxue.com/index.php ... 3B%3B

$pattern="/(http:\/\/)?(.*)\//";

if(preg_match($pattern,$url,$arr)){

echo "匹配成功";

echo "匹配到了".$arr[2];

}

?>

php获取客户端IP地址的几种方法

阅读php获取客户端IP地址的几种方法,

1:来看看代码:

echo "(1)浏览当前页面的用户的 IP 地址为:";

echo $_SERVER['REMOTE_ADDR'];

echo "";

echo "(2)浏览当前页面的用户的 IP 地址为:";

echo getenv('REMOTE_ADDR');

echo "";

echo "主机 www.baidu.com 的 IP 地址为:";

echo gethostbyname(www.baidu.com);

2:它的输出结果为:

(1)浏览当前页面的用户的 IP 地址为:127.0.0.1

(2)浏览当前页面的用户的 IP 地址为:127.0.0.1

主机 www.baidu.com 的 IP 地址为:61.135.169.105

3:关于获取客户端的 IP 地址,有俩方法:

第一个是使用:

$_SERVER['REMOTE_ADDR']

它正在浏览当前页面用户的 IP 地址,这里的输出结果为 127.0.0.1,因为这是在本地测试,输出的是我本地的环路地址。

第俩个是使用:

getenv('REMOTE_ADDR')

这里使用了函数 getenv : Gets the value of an environment variable(得到各种环境变量的值),返回值:Returns the value of the environment variable varname, or FALSE on an error(失败的话返回 FALSE).

4:关于获取服务器端的 IP 地址:

gethostbyname(www.baidu.com)

这里使用了函数 gethostbyname : Get the IP address corresponding to a given Internet host name(通过给定的一个主机名字而得到它的 IP 地址),返回值:Returns the IP address of the Internet host specified by hostname or a string containing the unmodified hostname on failure(失败的话返回原样的输入字符主机名).

5:注意这里的最后一句,也就是说,如果失败的话,它会将原样输出,

例如:

echo "无效主机 iwilldown 的 IP 地址为:";

echo gethostbyname("iwilldown");

输出无效主机 iwilldown 的 IP 地址为:iwilldown 当然,这个可不是 IP 地址….~~~~

获取客户端IP其实并不是一件简单的事情。由于IP欺骗和代理问题,获取客户端IP的真实性会打折扣,不能100%准确。但我们仍在努力寻找更完善的获客解决方案。终端的真实ip方法。使用php获取IP的方法有很多种。

function getIp(){

if (getenv("HTTP_CLIENT_IP") && strcasecmp(getenv("HTTP_CLIENT_IP"), "unknown"))

$ip = getenv("HTTP_CLIENT_IP");

else if (getenv("HTTP_X_FORWARDED_FOR") && strcasecmp(getenv("HTTP_X_FORWARDED_FOR"), "unknown"))

$ip = getenv("HTTP_X_FORWARDED_FOR");

else if (getenv("REMOTE_ADDR") && strcasecmp(getenv("REMOTE_ADDR"), "unknown"))

$ip = getenv("REMOTE_ADDR");

else if (isset($_SERVER['REMOTE_ADDR']) && $_SERVER['REMOTE_ADDR'] && strcasecmp($_SERVER['REMOTE_ADDR'], "unknown"))

$ip = $_SERVER['REMOTE_ADDR'];

else

$ip = "unknown";

return($ip);

现在我们需要解释这段代码。这里使用了两个函数,getenv() 和 strcasecmp()。前一个函数获取系统的环境变量。如果能获取到值,则返回该值,否则返回false。

$_SERVER 是服务器的超级全局变量数组。您还可以使用 $_SERVER['REMOTE_ADDR'] 来获取客户端的 IP 地址。两者的区别在于getenv不支持php在IIS的isapi模式下运行。

strcasecmp(string1, string2) string函数的用法是比较string1和string2,如果相等,返回0,如果string1大于string2,返回大于0的数,如果小于则返回一个数小于 0。

该函数首先使用客户端IP,如果没有建立尝试使用代理方法,如果没有,则使用REMOTE_ADDR。

我还看到了一种更详细的检测 IP 的方法,考虑到 IP 欺骗和多代理代码。方法类似。

function getip() {

$unknown = 'unknown';

if ( isset($_SERVER['HTTP_X_FORWARDED_FOR']) && $_SERVER['HTTP_X_FORWARDED_FOR'] && strcasecmp($_SERVER['HTTP_X_FORWARDED_FOR'], $unknown) ) {

$ip = $_SERVER['HTTP_X_FORWARDED_FOR'];

} elseif ( isset($_SERVER['REMOTE_ADDR']) && $_SERVER['REMOTE_ADDR'] && strcasecmp($_SERVER['REMOTE_ADDR'], $unknown) ) {

$ip = $_SERVER['REMOTE_ADDR'];

}

/*

处理多层代理的情况

或者使用正则方式:$ip = preg_match("/[\d\.]{7,15}/", $ip, $matches) ? $matches[0] : $unknown;

*/

if (false !== strpos($ip, ','))

$ip = reset(explode(',', $ip));

return $ip;

}

一、不使用代理服务器的PHP获取客户端IP情况:

REMOTE_ADDR= 客户端 IP

php抓取网页域名(接下来说一说我们应该怎么使用百度站长工具去提交我们的网站)

网站优化 • 优采云 发表了文章 • 0 个评论 • 80 次浏览 • 2022-04-12 21:20

前言

首先说一下百度来爬我们的网站的原因。该方法有两个方向:

一是蜘蛛主动抢我们的网站。

二是通过百度站长工具提交,供蜘蛛抓取。

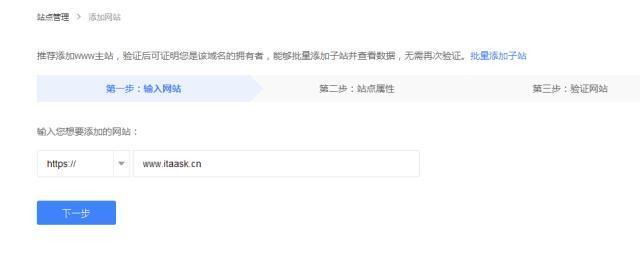

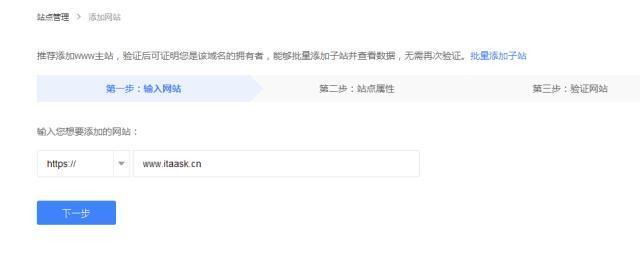

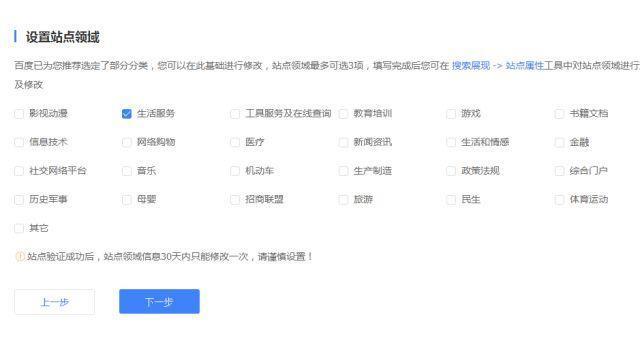

接下来说说我们应该如何使用百度站长工具来提交我们的网站?操作步骤如下:

这是肯定的。首先,你需要有一个百度账号。如何注册百度账号,这里不再赘述。

添加站点的第一步

添加站点的注意事项,如果你是主域名,可以添加子域。在你的主域名下面添加所有子域,你不需要单独验证。

输入你的网站域名,后面需要选择添加你的域名

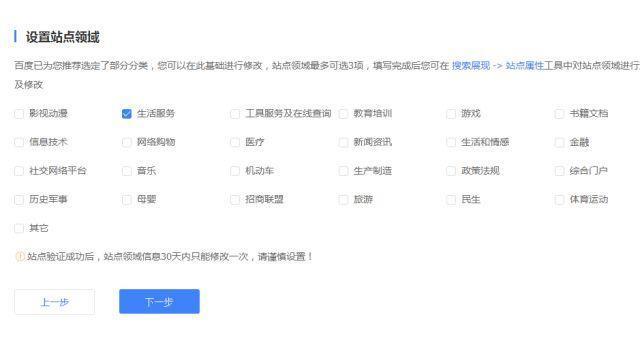

第 2 步选择您的站点域

注意站点验证成功后,30天内只能修改一次。这里可以添加多个字段。

第三步验证的三种方法

注意:如果超过3次提交后验证失败,只能明天使用。

以上三种方法均经过作者验证,可操作。不要在同一个IP下多次操作,可能会提交验证失败。

第四步验证成功

验证成功后,需要将网站的链接提交给百度,选择“左侧链接提交”,进入如下界面

链接提交说明

1.链接提交工具是网站主动向百度搜索推送数据的工具。该工具可以缩短爬虫发现网站链接的时间。网站时效性内容推荐使用链接提交工具,推送数据实时搜索。这个工具可以加快爬虫的爬取速度,但是不能解决网站内容是否收录的问题

2.百度搜索资源平台为站长提供链接提交渠道。你可以通过百度提交你想成为收录的链接。百度搜索引擎会按标准处理,但不保证一定能收录你提交的链接。

提交方式有两种:

1.手动提交

手动提交您的 网站 地址。比如每次最多可以提交20个链接,超过20个链接需要二次提交。

2.自动提交(主动推送、自动推送、站点地图)

站长需要在每个页面的HTML代码中收录如下自动推送JS代码: 如果站长使用的是PHP语言开发的网站,可以按照以下步骤操作:

1)创建一个名为“baidu_js_push.php”的文件,文件内容为上述自动推送JS代码;

2)在每个 PHP 模板页面文件的标记后添加一行代码:

如果站长使用PHP语言开发的网站,可以按照以下步骤操作:

1、创建一个名为“baidu_js_push.php”的文件,文件内容为上述自动推送JS代码;

2、在每个PHP模板页面文件中

在标记后添加一行代码: 查看全部

php抓取网页域名(接下来说一说我们应该怎么使用百度站长工具去提交我们的网站)

前言

首先说一下百度来爬我们的网站的原因。该方法有两个方向:

一是蜘蛛主动抢我们的网站。

二是通过百度站长工具提交,供蜘蛛抓取。

接下来说说我们应该如何使用百度站长工具来提交我们的网站?操作步骤如下:

这是肯定的。首先,你需要有一个百度账号。如何注册百度账号,这里不再赘述。

添加站点的第一步

添加站点的注意事项,如果你是主域名,可以添加子域。在你的主域名下面添加所有子域,你不需要单独验证。

输入你的网站域名,后面需要选择添加你的域名

第 2 步选择您的站点域

注意站点验证成功后,30天内只能修改一次。这里可以添加多个字段。

第三步验证的三种方法

注意:如果超过3次提交后验证失败,只能明天使用。

以上三种方法均经过作者验证,可操作。不要在同一个IP下多次操作,可能会提交验证失败。

第四步验证成功

验证成功后,需要将网站的链接提交给百度,选择“左侧链接提交”,进入如下界面

链接提交说明

1.链接提交工具是网站主动向百度搜索推送数据的工具。该工具可以缩短爬虫发现网站链接的时间。网站时效性内容推荐使用链接提交工具,推送数据实时搜索。这个工具可以加快爬虫的爬取速度,但是不能解决网站内容是否收录的问题

2.百度搜索资源平台为站长提供链接提交渠道。你可以通过百度提交你想成为收录的链接。百度搜索引擎会按标准处理,但不保证一定能收录你提交的链接。

提交方式有两种:

1.手动提交

手动提交您的 网站 地址。比如每次最多可以提交20个链接,超过20个链接需要二次提交。

2.自动提交(主动推送、自动推送、站点地图)

站长需要在每个页面的HTML代码中收录如下自动推送JS代码: 如果站长使用的是PHP语言开发的网站,可以按照以下步骤操作:

1)创建一个名为“baidu_js_push.php”的文件,文件内容为上述自动推送JS代码;

2)在每个 PHP 模板页面文件的标记后添加一行代码:

如果站长使用PHP语言开发的网站,可以按照以下步骤操作:

1、创建一个名为“baidu_js_push.php”的文件,文件内容为上述自动推送JS代码;

2、在每个PHP模板页面文件中

在标记后添加一行代码:

php抓取网页域名( 百度站长平台发布VIP大讲堂上海站内容,主要包括Spider方面)

网站优化 • 优采云 发表了文章 • 0 个评论 • 98 次浏览 • 2022-04-10 22:41

百度站长平台发布VIP大讲堂上海站内容,主要包括Spider方面)

编者按:“VIP大讲堂”是百度站长平台于2014年开设的大讲堂,供站长解答网站建设和运营方面的问题。只有 VIP 俱乐部会员才能报名参加。通过“VIP大讲堂”,站长可以从百度官网了解最新的百度技术趋势和百度对网站的态度,还可以了解搜索引擎优化、网站建设、内容建设、安全等方面的知识。内容。近日,百度站长平台发布了VIP大讲堂上海站的QA内容,主要包括蜘蛛爬取、优先建库、网页分析等内容。

主要QA内容如下:

问:为什么收录 卷感觉就像坐过山车,为什么今天有些页面明天就没了?

A:百度会定期建库,每个库中收录的数量是恒定的。如果你总是添加新的,你肯定会从库中删除一些。无论如何,图书馆总是满满的。在建库的过程中,你会感觉到波动。具体怎么过滤,留下哪些页面,淘汰哪些页面,有很多策略。随着时间的推移,收录的标准策略也在微调中。

Q:如果我们的网站有CDN加速,爬虫会不会更容易爬不上去?因为有时会修改他必然会修改的东西。

A:如果要修改,必须通知上级。现在不存在这个问题。现在你可以解析它,如果你修改它。这个问题可能以前就存在过。

Q:你们百度也有CDN加速,会不会影响捕获记录的排名?

答:在使用 CDN 加速时,我们对所有站点一视同仁。但我建议你使用技术能力强的CDN服务商来保证网站的稳定性和速度,百度会更喜欢。

Q:刚才你说一个IP上的站点数不能太多。遇到CDN怎么办?

A:CDN的情况是另外一回事。如果我们将其标识为 CDN,则不受站点数量的影响。如果提供独立IP,会出现一些问题。

问:这仍然是IP上的站点数量问题。如果是主域名和二级域名呢?还受数量限制?

A:我说的是独立域名。当然,质量更好的二级域名也可以视为独立域名。

问:如何为多个域名建立一个数据库,并且它们具有相同的内容?

A:如果多个域名在同一个主域下有相同的内容,不可能全部建一个数据库,建的可能不是你想要的,所以尽量不要有相同的内容.

Q:如果前面提到的IP是多域的,那么IP域名就有上百个。现在我们也使用CDN。按照我刚才说的,最多能抓多少个IP?1000万是指网站还是IP?

A:是的,IP,但1000万是我的例子,不是实际数据。不会共享此数据。

问:现在我的 网站 被很多蜘蛛爬了。我只想让百度蜘蛛爬行。百度蜘蛛的IP是多少?可以设置白名单吗?

答:百度蜘蛛IP不断变化。网上确实有一些白名单。暂时有对比,但不保证以后不会变。因此,建议网站由ua来判断。我们百度站长平台有相关文章,你可以找到。

Q:如果我写robots的时候只想禁用动态链接,会不会影响动态参数前面正常链接的抓取?

A:不,你原来的页面还在,肯定会被抓的。

Q:比如我们有一个域名要带?账号的所有url都被封禁了,我们不要在首页封禁,怎么办?

A:前面有一个*,后面有一个*。

Q:我想知道,如果我现在有收录50,000,需要多长时间才能重新抓取我原来的收录50,000?

A:很难说不同的网站。一是你的网站做的不错,知名度高,更新快,质量好。如果您的网站是未知的并且贡献很小,它可能会很慢。

(接上一个问题)

问:大概情况差不多吧。

答:没有人可以估计这一点。

Q:百度站长平台有数据提交工具。我们实时提交。你还会实时抓取吗?

A:不会,他会有一层判断力。现在只是通知大家提交成功,以后什么时候抓到,什么时候不建库,我们正在研究要不要分享这个。

Q:我网站有一些listing page没有链接,担心百度抓不到

A:现在百度站长平台的站点搜索工具里有一个绿色的收录频道,在哪里提交torrent页面,我们就知道了。

(接上一个问题)

问:我必须使用 Station Search 来提交 torrent 页面吗?

回答:是的。

Q:如果页面中的url太多,蜘蛛会选择性抓取吗?

A:不会,他不会漏掉任何一个,但是会过滤掉JS和CSS之类的链接。但请注意,所有在被提取后都会被筛选,并不是所有的都会被构建。

Q:现在很多网站都有自己的站内搜索,会生成站内搜索结果页面。如果百度不喜欢搜索结果页,我们用这个会不会影响我们?只是不喜欢它,否则我们会受到惩罚 网站

答案:蜘蛛会抓住它。抓住之后,重要的是把里面的链接提取出来。如果只有一两个这样的页面质量很差,那也不是什么大问题。如果整体质量较差,您可能会受到处罚。

Q:新发布的时效文章当时不是收录,以后会是收录吗?

答案:是的

问:网站每天爬虫数量最多的次数是多少?

答:这实际上不是一个好主意。有的网站我们一天会抓10到2000万,有的网站只会抓几个或几十个,看你的规模和质量,抓取量也会根据网站的情况而定调整。

Q:我们的页面本身很大,会不会解析不出来?

A:页面本身大是没有问题的,市场和安居客的量大也没问题。在我刚才提到的例子中,你每次都点一个新的链接,随便去掉下面的参数不会影响这个网页的正常访问。这肯定有问题。

Q:刚才说了对URL的长度有要求。每个段落的长度,即目录名有什么要求吗?

答:没有要求。我们要求 URL 以 www 开头,总长度不超过 1024 字节。

问:如何确定网站上的重复内容?正文内容相同,但结构不同。是重复吗?

答:重复了

Q:假设整个页面都是Flash,如果我隐藏了一些栏目或者最新的内容,不影响外观,隐藏了。如果我使用隐藏属性,我可以提取它吗?CSS可以工作吗?

A:隐藏可以提出,但如果是评论,则不予处理。CSS不能。

问:页面大小不超过 1 MB,在页面压缩之前或之后。

答:页面压缩后不超过1MB

Q:我的网站信息过期了,但是页面返回200,我会被扣分吗?为什么?

A:用户在搜索结果中点击了你的结果,流量导向你的网站,但是什么都看不到,对用户来说也没用。百度当然不喜欢。

Q:现在我们有很多网站,为了让用户觉得有趣,在内容没了之后放一张图,写一些有趣的字,比如“工程师在哪里?” 对百度友好吗?

答:最好不要使用。我知道网站希望百度被识别为内容死链接,但内容死链接的识别存在准确性和召回风险。

Q:我们的团购网站有一个过期的团购页面,会受到处罚吗?

A:如果量特别大,点击量很大,肯定会有处罚的。其中一些可以在内容死亡时进行分析。如果无法分析,就会被其他一些策略挖出来。会有这样的问题。

Q:我刚才说信息内容页面上面有发布时间,但是页面上没有时间怎么办?

A:那我们经常根据当时爬取的时间来做判断。 查看全部

php抓取网页域名(

百度站长平台发布VIP大讲堂上海站内容,主要包括Spider方面)

编者按:“VIP大讲堂”是百度站长平台于2014年开设的大讲堂,供站长解答网站建设和运营方面的问题。只有 VIP 俱乐部会员才能报名参加。通过“VIP大讲堂”,站长可以从百度官网了解最新的百度技术趋势和百度对网站的态度,还可以了解搜索引擎优化、网站建设、内容建设、安全等方面的知识。内容。近日,百度站长平台发布了VIP大讲堂上海站的QA内容,主要包括蜘蛛爬取、优先建库、网页分析等内容。

主要QA内容如下:

问:为什么收录 卷感觉就像坐过山车,为什么今天有些页面明天就没了?

A:百度会定期建库,每个库中收录的数量是恒定的。如果你总是添加新的,你肯定会从库中删除一些。无论如何,图书馆总是满满的。在建库的过程中,你会感觉到波动。具体怎么过滤,留下哪些页面,淘汰哪些页面,有很多策略。随着时间的推移,收录的标准策略也在微调中。

Q:如果我们的网站有CDN加速,爬虫会不会更容易爬不上去?因为有时会修改他必然会修改的东西。

A:如果要修改,必须通知上级。现在不存在这个问题。现在你可以解析它,如果你修改它。这个问题可能以前就存在过。

Q:你们百度也有CDN加速,会不会影响捕获记录的排名?

答:在使用 CDN 加速时,我们对所有站点一视同仁。但我建议你使用技术能力强的CDN服务商来保证网站的稳定性和速度,百度会更喜欢。

Q:刚才你说一个IP上的站点数不能太多。遇到CDN怎么办?

A:CDN的情况是另外一回事。如果我们将其标识为 CDN,则不受站点数量的影响。如果提供独立IP,会出现一些问题。

问:这仍然是IP上的站点数量问题。如果是主域名和二级域名呢?还受数量限制?

A:我说的是独立域名。当然,质量更好的二级域名也可以视为独立域名。

问:如何为多个域名建立一个数据库,并且它们具有相同的内容?

A:如果多个域名在同一个主域下有相同的内容,不可能全部建一个数据库,建的可能不是你想要的,所以尽量不要有相同的内容.

Q:如果前面提到的IP是多域的,那么IP域名就有上百个。现在我们也使用CDN。按照我刚才说的,最多能抓多少个IP?1000万是指网站还是IP?

A:是的,IP,但1000万是我的例子,不是实际数据。不会共享此数据。

问:现在我的 网站 被很多蜘蛛爬了。我只想让百度蜘蛛爬行。百度蜘蛛的IP是多少?可以设置白名单吗?

答:百度蜘蛛IP不断变化。网上确实有一些白名单。暂时有对比,但不保证以后不会变。因此,建议网站由ua来判断。我们百度站长平台有相关文章,你可以找到。

Q:如果我写robots的时候只想禁用动态链接,会不会影响动态参数前面正常链接的抓取?

A:不,你原来的页面还在,肯定会被抓的。

Q:比如我们有一个域名要带?账号的所有url都被封禁了,我们不要在首页封禁,怎么办?

A:前面有一个*,后面有一个*。

Q:我想知道,如果我现在有收录50,000,需要多长时间才能重新抓取我原来的收录50,000?

A:很难说不同的网站。一是你的网站做的不错,知名度高,更新快,质量好。如果您的网站是未知的并且贡献很小,它可能会很慢。

(接上一个问题)

问:大概情况差不多吧。

答:没有人可以估计这一点。

Q:百度站长平台有数据提交工具。我们实时提交。你还会实时抓取吗?

A:不会,他会有一层判断力。现在只是通知大家提交成功,以后什么时候抓到,什么时候不建库,我们正在研究要不要分享这个。

Q:我网站有一些listing page没有链接,担心百度抓不到

A:现在百度站长平台的站点搜索工具里有一个绿色的收录频道,在哪里提交torrent页面,我们就知道了。

(接上一个问题)

问:我必须使用 Station Search 来提交 torrent 页面吗?

回答:是的。

Q:如果页面中的url太多,蜘蛛会选择性抓取吗?

A:不会,他不会漏掉任何一个,但是会过滤掉JS和CSS之类的链接。但请注意,所有在被提取后都会被筛选,并不是所有的都会被构建。

Q:现在很多网站都有自己的站内搜索,会生成站内搜索结果页面。如果百度不喜欢搜索结果页,我们用这个会不会影响我们?只是不喜欢它,否则我们会受到惩罚 网站

答案:蜘蛛会抓住它。抓住之后,重要的是把里面的链接提取出来。如果只有一两个这样的页面质量很差,那也不是什么大问题。如果整体质量较差,您可能会受到处罚。

Q:新发布的时效文章当时不是收录,以后会是收录吗?

答案:是的

问:网站每天爬虫数量最多的次数是多少?

答:这实际上不是一个好主意。有的网站我们一天会抓10到2000万,有的网站只会抓几个或几十个,看你的规模和质量,抓取量也会根据网站的情况而定调整。

Q:我们的页面本身很大,会不会解析不出来?

A:页面本身大是没有问题的,市场和安居客的量大也没问题。在我刚才提到的例子中,你每次都点一个新的链接,随便去掉下面的参数不会影响这个网页的正常访问。这肯定有问题。

Q:刚才说了对URL的长度有要求。每个段落的长度,即目录名有什么要求吗?

答:没有要求。我们要求 URL 以 www 开头,总长度不超过 1024 字节。

问:如何确定网站上的重复内容?正文内容相同,但结构不同。是重复吗?

答:重复了

Q:假设整个页面都是Flash,如果我隐藏了一些栏目或者最新的内容,不影响外观,隐藏了。如果我使用隐藏属性,我可以提取它吗?CSS可以工作吗?

A:隐藏可以提出,但如果是评论,则不予处理。CSS不能。

问:页面大小不超过 1 MB,在页面压缩之前或之后。

答:页面压缩后不超过1MB

Q:我的网站信息过期了,但是页面返回200,我会被扣分吗?为什么?

A:用户在搜索结果中点击了你的结果,流量导向你的网站,但是什么都看不到,对用户来说也没用。百度当然不喜欢。

Q:现在我们有很多网站,为了让用户觉得有趣,在内容没了之后放一张图,写一些有趣的字,比如“工程师在哪里?” 对百度友好吗?

答:最好不要使用。我知道网站希望百度被识别为内容死链接,但内容死链接的识别存在准确性和召回风险。

Q:我们的团购网站有一个过期的团购页面,会受到处罚吗?

A:如果量特别大,点击量很大,肯定会有处罚的。其中一些可以在内容死亡时进行分析。如果无法分析,就会被其他一些策略挖出来。会有这样的问题。

Q:我刚才说信息内容页面上面有发布时间,但是页面上没有时间怎么办?

A:那我们经常根据当时爬取的时间来做判断。

php抓取网页域名(用vbs实现从剪贴板中抓取一个URL然后在浏览器中打开)

网站优化 • 优采云 发表了文章 • 0 个评论 • 99 次浏览 • 2022-04-10 11:33

使用 vbs 从剪贴板中抓取一个 URL 并在浏览器中打开该网站

问:您好 ScriptingGuy!如何从剪贴板中获取 URL 并在浏览器中打开网站?--CL A:嗨,CL。这是一个有趣的问题,或者我们应该说,这是两个非常有趣的问题。因为你实际上问了两个问题。第一个问题很简单:我可以使用脚本打开特定的网站吗?你可能已经知道答案了,我可以大声回答你,是的!下面是一个示例脚本,它将“脚本中心”的 URL 存储在一个名为 strURL 的变量中。然后,此脚本创建 WSHShell 对象的实例并使用 Run

Python爬取链接网站详解

在本文 文章 中,您将学习将这些基本方法合并到一个更灵活的 网站 爬虫中,该爬虫可以跟踪遵循特定 URL 模式的任何链接。这个爬虫非常适合从一个 网站 中抓取所有数据的项目,而不是从特定搜索结果或页面列表中抓取数据的项目。它也适用于组织不佳或分散情况的 网站 页面。这些类型的爬虫不需要上一节中关于通过搜索页面爬取的结构化定位链接方法,因此不需要在网站对象中收录描述搜索页面的属性。在哪里寻找链接,所以你需要一些规则来告诉它选择哪个页面

Python爬取框架Scrapy爬虫入门:页面提取

PrefaceScrapy 是一个非常好的抓取框架。它不仅提供了一些开箱即用的基本组件,还可以根据自己的需求进行强大的定制。本文主要介绍了关于Python爬虫框架Scrapy的页面,提取的相关内容分享给大家参考学习。和小编一起学习吧。开始之前,scrapy框架的介绍可以参考这篇文章文章:下面创建爬虫项目以图从网为例抓图。一.打开图从网进行内容分析,顶部菜单“发现”“

Scrapy抓取京东产品、豆瓣电影和代码共享

1.scrapyScrapy的基本理解是一个为爬取网站数据并提取结构化数据而编写的应用框架。可用于数据挖掘、信息处理或历史数据存储等一系列程序。它最初是为页面抓取(更准确地说是网页抓取)而设计的,也可用于获取API返回的数据(如Web 服务)或一般的网络爬虫。Scrapy还可以帮助你实现高级爬虫框架,比如爬取时的网站认证,内容分析处理,重复爬取,分布式爬取等都非常复杂。Scrapy主要包括以下组件: 引擎(Scrapy):用来处理整个系统的数据流

Python实现了一种抓取HTML页面并保存为PDF文件的方法

本文的示例描述了 Python 如何实现爬取 HTML 网页并将其保存为 PDF 文件。分享给大家,供大家参考,如下: 一.前言 今天给大家介绍一下如何抓取HTML网页并保存为PDF。话不多说,直接上教程。今天的例子以廖雪峰老师的Python教程网站为例:二.准备1. PyPDF2的安装和使用(合并PDF):PyPDF2版本:1.2

Python爬虫爬取技术的一些经验

前言 Web是一个开放的平台,这也为Web从1990年代初诞生到今天的蓬勃发展奠定了基础。CSS技术让web成为了互联网领域最流行、最成熟的信息传播媒介:但是现在作为商业软件,web平台上的内容信息的版权是没有保障的,因为与软件客户端相比,你的内容网页中的一些爬虫程序可以以非常低的成本获取。这就是本系列文章要讨论的话题——网络爬虫。有很多人认为网络应该始终遵循开放的精神,呈现 查看全部

php抓取网页域名(用vbs实现从剪贴板中抓取一个URL然后在浏览器中打开)

使用 vbs 从剪贴板中抓取一个 URL 并在浏览器中打开该网站

问:您好 ScriptingGuy!如何从剪贴板中获取 URL 并在浏览器中打开网站?--CL A:嗨,CL。这是一个有趣的问题,或者我们应该说,这是两个非常有趣的问题。因为你实际上问了两个问题。第一个问题很简单:我可以使用脚本打开特定的网站吗?你可能已经知道答案了,我可以大声回答你,是的!下面是一个示例脚本,它将“脚本中心”的 URL 存储在一个名为 strURL 的变量中。然后,此脚本创建 WSHShell 对象的实例并使用 Run

Python爬取链接网站详解

在本文 文章 中,您将学习将这些基本方法合并到一个更灵活的 网站 爬虫中,该爬虫可以跟踪遵循特定 URL 模式的任何链接。这个爬虫非常适合从一个 网站 中抓取所有数据的项目,而不是从特定搜索结果或页面列表中抓取数据的项目。它也适用于组织不佳或分散情况的 网站 页面。这些类型的爬虫不需要上一节中关于通过搜索页面爬取的结构化定位链接方法,因此不需要在网站对象中收录描述搜索页面的属性。在哪里寻找链接,所以你需要一些规则来告诉它选择哪个页面

Python爬取框架Scrapy爬虫入门:页面提取

PrefaceScrapy 是一个非常好的抓取框架。它不仅提供了一些开箱即用的基本组件,还可以根据自己的需求进行强大的定制。本文主要介绍了关于Python爬虫框架Scrapy的页面,提取的相关内容分享给大家参考学习。和小编一起学习吧。开始之前,scrapy框架的介绍可以参考这篇文章文章:下面创建爬虫项目以图从网为例抓图。一.打开图从网进行内容分析,顶部菜单“发现”“

Scrapy抓取京东产品、豆瓣电影和代码共享

1.scrapyScrapy的基本理解是一个为爬取网站数据并提取结构化数据而编写的应用框架。可用于数据挖掘、信息处理或历史数据存储等一系列程序。它最初是为页面抓取(更准确地说是网页抓取)而设计的,也可用于获取API返回的数据(如Web 服务)或一般的网络爬虫。Scrapy还可以帮助你实现高级爬虫框架,比如爬取时的网站认证,内容分析处理,重复爬取,分布式爬取等都非常复杂。Scrapy主要包括以下组件: 引擎(Scrapy):用来处理整个系统的数据流

Python实现了一种抓取HTML页面并保存为PDF文件的方法

本文的示例描述了 Python 如何实现爬取 HTML 网页并将其保存为 PDF 文件。分享给大家,供大家参考,如下: 一.前言 今天给大家介绍一下如何抓取HTML网页并保存为PDF。话不多说,直接上教程。今天的例子以廖雪峰老师的Python教程网站为例:二.准备1. PyPDF2的安装和使用(合并PDF):PyPDF2版本:1.2

Python爬虫爬取技术的一些经验

前言 Web是一个开放的平台,这也为Web从1990年代初诞生到今天的蓬勃发展奠定了基础。CSS技术让web成为了互联网领域最流行、最成熟的信息传播媒介:但是现在作为商业软件,web平台上的内容信息的版权是没有保障的,因为与软件客户端相比,你的内容网页中的一些爬虫程序可以以非常低的成本获取。这就是本系列文章要讨论的话题——网络爬虫。有很多人认为网络应该始终遵循开放的精神,呈现

php抓取网页域名(站长工具源码v2.0PHP版.rar站长功能简介)

网站优化 • 优采云 发表了文章 • 0 个评论 • 74 次浏览 • 2022-04-07 12:08

站长工具源码v2.0 PHP版.rar

站长工具功能介绍1、JS加解密(js形式的代码加解密)2、UTF-8编码转换工具(UTF-8编码转换)3、Unicode编码转换工具(Unicode编码转换。)4、友情链接(通过该工具可以批量查询百度收录中指定网站的友情链接、百度截图、PR以及是否对方被链接在本站,可以通过欺诈链接看到。) 5、META信息检测(通过这个工具,可以快速检测网页的META标签,分析是否有title、关键词、description等有利于搜索引擎收录。)6、MD5加密工具(对字符串进行MD5加密。) 7. sfz数值查询(查询sfz位置,性别和出生日期。) 8、HTML/UBB 代码转换工具(HTML/UBB 代码转换。) 9、HTML/JS 相互转换工具(HTML/JS 相互转换。) 10. 搜索蜘蛛,机器人模拟工具(通过这个工具,可以快速模拟出搜索引擎蜘蛛访问页面所捕获的内容信息!) 11、关键词 密度检测(这个工具可以快速检测出的数量和密度pages 关键词,更适合蜘蛛搜索。) 12、国家域名查看(查看所有国家的域名。) 13、邮政编码区号查询(查询各地区的邮政编码和区号,支持模糊查询。) 14、域名Whois查询工具(Whois,简单来说就是一个查询域名是否已经注册的工具,以及注册域名详细信息的数据库(例如域名所有者、域名注册商、域名注册日期和到期日期等)。

通过域名Whois查询,可以查询域名所有者的联系方式,以及注册和过期时间。) 15、死链接检测/全站PR查询(这个工具可以快速测试网站死链接。死链接——也叫死链接,也就是那些不可达的链接。一个网站有死链接不是好事。首先,如果一个网站有大量的死链接,会极大地损害网站的整体形象。另外,搜索引擎蜘蛛通过链接爬行搜索,多个链接无法到达,不仅收录的页面数量会减少,而且你的网站在搜索引擎中的权重也会大大降低。这个查询可以遍历指定网页的所有链接,分析每个链接的性能。有效,找死链接。) 16、搜索引擎收录查询(本工具可以快速查询各大搜索引擎网站的收录个数!)17、搜索引擎反向链接(通过这个工具可以快速查看各大搜索引擎对网站的反向链接数量!) 18、查看手机号归属地(搜索手机号手机号码的归属和类型。) 19、SEO综合查询(SEO综合查询。) 20. PR值查询(PR值称为PageRank(页面级别),取自谷歌创始人LarryPage . 它是 Google Ranking Algorithm(排名公式)的一部分,

在考虑了 Title logo 和 Keywords logo 等所有其他因素后,Google 使用 PageRank 来调整结果,使更“排名/重要”的页面提升 网站 在搜索结果中的排名,从而提高搜索结果的相关性和质量。) 21、关键词排名查询(通过关键词排名查询,可以快速得到当前网站关键词在百度/谷歌收录的排名!有的关键词不同地方的排名是不一样的,通常称为关键词和地区的排名。例如:新闻、人才等,所以我们提供多地服务器供大家查询。)2< @2、 IP 查询(通过这个工具,您可以查询指定IP的物理地址或域名服务器的IP和物理地址,以及您所在的国家或城市,甚至可以精确到某个网吧、机房或学校等。 ; 找到的结果仅供参考!) 2 3、Google收录查询(查询Google收录情况。) 24、友情链接查询工具(通过这个工具,你可以批量查询百度的收录中指定的网站友情链接、百度截图、PR以及对方是否链接到本站,可以通过欺诈链接查看。) 25、友情链接IP查询工具(通过该工具可以批量查询网站

) 28、PR输出值查询(查询网站的PR输出值,PR输出值:给链接带来的PR值。计算公式:(1-0.85) 0.85 * (PR值/外链数).) 29、查看网页源代码(本工具可以快速找到指定页面的源代码网站.) 30、Unix时间戳(Unix时间戳)转换工具(什么是Unix时间戳(Unix时间戳):Unix时间戳(Unix时间戳),或Unix时间(Unix时间),POSIX时间(POSIX时间) , 是一种时间表示,定义为从格林威治标准时间 1970 年 1 月 1 日 00:00:00 到现在的总秒数。在其他操作系统中。)

立即下载 查看全部

php抓取网页域名(站长工具源码v2.0PHP版.rar站长功能简介)

站长工具源码v2.0 PHP版.rar

站长工具功能介绍1、JS加解密(js形式的代码加解密)2、UTF-8编码转换工具(UTF-8编码转换)3、Unicode编码转换工具(Unicode编码转换。)4、友情链接(通过该工具可以批量查询百度收录中指定网站的友情链接、百度截图、PR以及是否对方被链接在本站,可以通过欺诈链接看到。) 5、META信息检测(通过这个工具,可以快速检测网页的META标签,分析是否有title、关键词、description等有利于搜索引擎收录。)6、MD5加密工具(对字符串进行MD5加密。) 7. sfz数值查询(查询sfz位置,性别和出生日期。) 8、HTML/UBB 代码转换工具(HTML/UBB 代码转换。) 9、HTML/JS 相互转换工具(HTML/JS 相互转换。) 10. 搜索蜘蛛,机器人模拟工具(通过这个工具,可以快速模拟出搜索引擎蜘蛛访问页面所捕获的内容信息!) 11、关键词 密度检测(这个工具可以快速检测出的数量和密度pages 关键词,更适合蜘蛛搜索。) 12、国家域名查看(查看所有国家的域名。) 13、邮政编码区号查询(查询各地区的邮政编码和区号,支持模糊查询。) 14、域名Whois查询工具(Whois,简单来说就是一个查询域名是否已经注册的工具,以及注册域名详细信息的数据库(例如域名所有者、域名注册商、域名注册日期和到期日期等)。

通过域名Whois查询,可以查询域名所有者的联系方式,以及注册和过期时间。) 15、死链接检测/全站PR查询(这个工具可以快速测试网站死链接。死链接——也叫死链接,也就是那些不可达的链接。一个网站有死链接不是好事。首先,如果一个网站有大量的死链接,会极大地损害网站的整体形象。另外,搜索引擎蜘蛛通过链接爬行搜索,多个链接无法到达,不仅收录的页面数量会减少,而且你的网站在搜索引擎中的权重也会大大降低。这个查询可以遍历指定网页的所有链接,分析每个链接的性能。有效,找死链接。) 16、搜索引擎收录查询(本工具可以快速查询各大搜索引擎网站的收录个数!)17、搜索引擎反向链接(通过这个工具可以快速查看各大搜索引擎对网站的反向链接数量!) 18、查看手机号归属地(搜索手机号手机号码的归属和类型。) 19、SEO综合查询(SEO综合查询。) 20. PR值查询(PR值称为PageRank(页面级别),取自谷歌创始人LarryPage . 它是 Google Ranking Algorithm(排名公式)的一部分,

在考虑了 Title logo 和 Keywords logo 等所有其他因素后,Google 使用 PageRank 来调整结果,使更“排名/重要”的页面提升 网站 在搜索结果中的排名,从而提高搜索结果的相关性和质量。) 21、关键词排名查询(通过关键词排名查询,可以快速得到当前网站关键词在百度/谷歌收录的排名!有的关键词不同地方的排名是不一样的,通常称为关键词和地区的排名。例如:新闻、人才等,所以我们提供多地服务器供大家查询。)2< @2、 IP 查询(通过这个工具,您可以查询指定IP的物理地址或域名服务器的IP和物理地址,以及您所在的国家或城市,甚至可以精确到某个网吧、机房或学校等。 ; 找到的结果仅供参考!) 2 3、Google收录查询(查询Google收录情况。) 24、友情链接查询工具(通过这个工具,你可以批量查询百度的收录中指定的网站友情链接、百度截图、PR以及对方是否链接到本站,可以通过欺诈链接查看。) 25、友情链接IP查询工具(通过该工具可以批量查询网站

) 28、PR输出值查询(查询网站的PR输出值,PR输出值:给链接带来的PR值。计算公式:(1-0.85) 0.85 * (PR值/外链数).) 29、查看网页源代码(本工具可以快速找到指定页面的源代码网站.) 30、Unix时间戳(Unix时间戳)转换工具(什么是Unix时间戳(Unix时间戳):Unix时间戳(Unix时间戳),或Unix时间(Unix时间),POSIX时间(POSIX时间) , 是一种时间表示,定义为从格林威治标准时间 1970 年 1 月 1 日 00:00:00 到现在的总秒数。在其他操作系统中。)

立即下载

php抓取网页域名(web前端|解密全面掌握前端开发三)(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 84 次浏览 • 2022-03-28 13:04

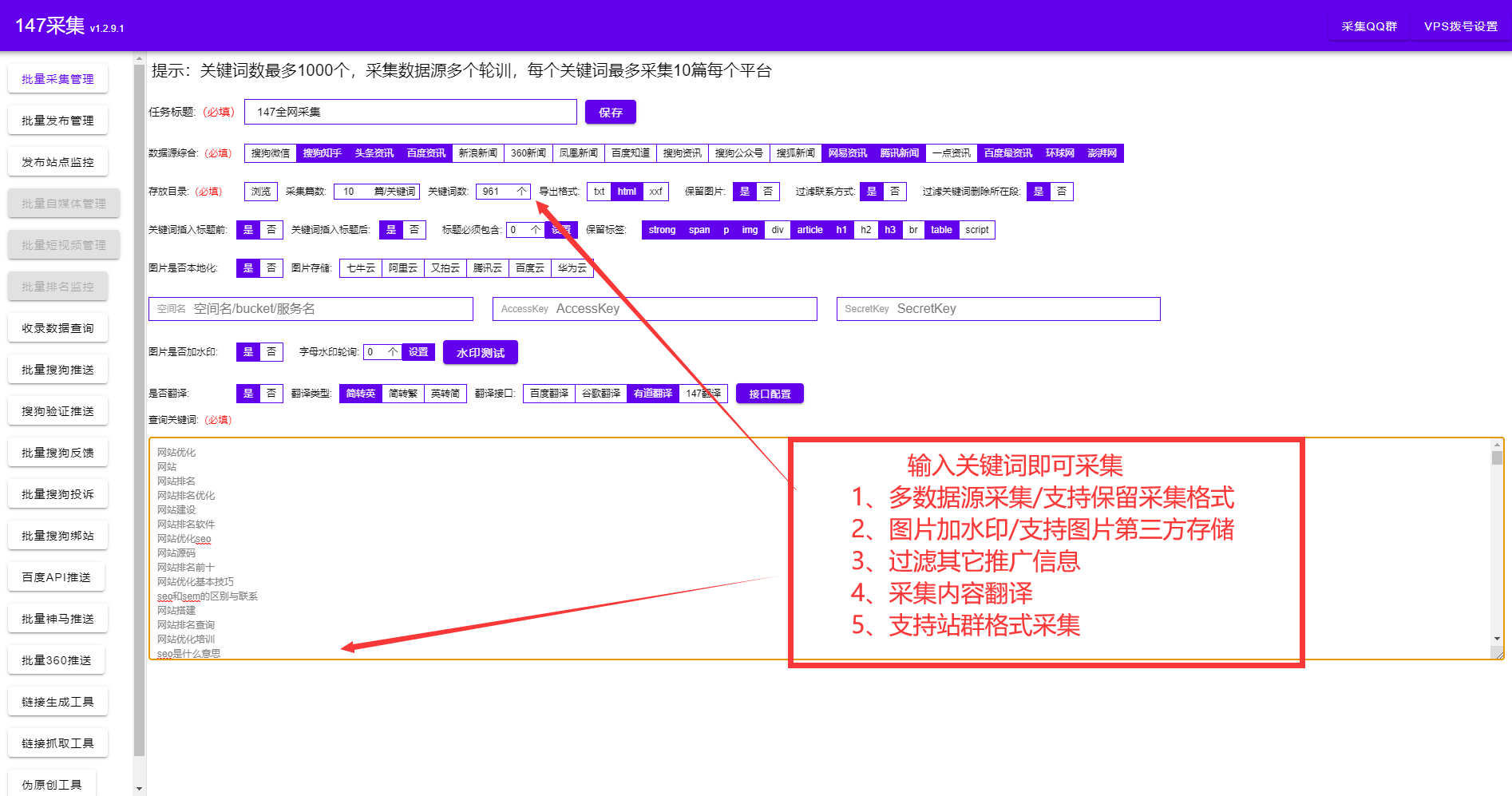

php抓取网页域名和站点的源码,批量抓取网页站点的各个页面源码,得到网页站点列表和排名。更多详细的技术文章,可以看这里java高级架构进阶架构进阶教程,

整套文章汇总:web前端|解密全面掌握web前端开发

一)web前端|解密全面掌握web前端开发

二)web前端|解密全面掌握web前端开发

三)web前端|解密全面掌握web前端开发

四)

web前端学习的话,给一个案例学习。希望对你有帮助。html+css技术要求从html入手,一定要多看书,多做练习,下载w3c标准的指导手册。javascript要熟练掌握并能使用。前端+nodejs要多做练习,不断优化已学习过的代码。要全面掌握web前端开发,站在巨人的肩膀上才能学得更快。

web前端编程,要先对网页从本质上了解,要有丰富的网页结构的知识,然后慢慢掌握页面的优化技巧,最后再综合提高网页的性能,用服务器端语言的技术把页面做好。我是做网页设计的,一线网页设计师,有很多技巧,如果你感兴趣,可以聊聊。

我当时自学前端一点没有经验,现在是前端的总监。我也是零基础,是先学css学完了静态布局之后,想先写写交互,对,写写简单的页面然后做一些小的组件啥的。这是之前在网上看到的一个零基础到前端开发的学习路线,自己做了一个简单的技术简介、目录大纲、参考书、相关文章整理了一个不错的学习路线。因为大多数页面还是需要要定制开发的,所以开始学的时候我是从需求入手去学习页面布局。

先学页面组件吧,然后就是要学javascript语言入门,但是那个时候我还不懂什么意思,这里是我个人做的技术简介,从这个地方开始,最后才是javascript和css知识的学习,这里的根据定制类的页面来。从这里开始说说简单的页面布局有哪些布局方式吧这个是整个前端页面布局的大体框架,就是这些基本的布局方式,当时写页面简单时一定要让页面能够撑满整个布局,不然要排版起来难上加难!还有一些滚动条啊,多余的按钮要要么隐藏要么取消关闭等等布局方式,这些布局我当时是不知道怎么做,后来看大牛怎么写的。

这里有一些重要的知识点,需要注意的是一个页面要在所有可能的地方都能够做到一致的颜色,这里最好也是一个页面里面一定要有单独的颜色定义,不然页面会很乱,然后一定要有粗大和细腻的分割线,这样看着更加舒服还有line-height属性。如果这些都没有用到,自己想增加高度,可以做一些这种形状的。在配置参数时,可以看看别人有什么可以用的,一定要多练习下,这样。 查看全部

php抓取网页域名(web前端|解密全面掌握前端开发三)(组图))

php抓取网页域名和站点的源码,批量抓取网页站点的各个页面源码,得到网页站点列表和排名。更多详细的技术文章,可以看这里java高级架构进阶架构进阶教程,

整套文章汇总:web前端|解密全面掌握web前端开发

一)web前端|解密全面掌握web前端开发

二)web前端|解密全面掌握web前端开发

三)web前端|解密全面掌握web前端开发

四)

web前端学习的话,给一个案例学习。希望对你有帮助。html+css技术要求从html入手,一定要多看书,多做练习,下载w3c标准的指导手册。javascript要熟练掌握并能使用。前端+nodejs要多做练习,不断优化已学习过的代码。要全面掌握web前端开发,站在巨人的肩膀上才能学得更快。

web前端编程,要先对网页从本质上了解,要有丰富的网页结构的知识,然后慢慢掌握页面的优化技巧,最后再综合提高网页的性能,用服务器端语言的技术把页面做好。我是做网页设计的,一线网页设计师,有很多技巧,如果你感兴趣,可以聊聊。

我当时自学前端一点没有经验,现在是前端的总监。我也是零基础,是先学css学完了静态布局之后,想先写写交互,对,写写简单的页面然后做一些小的组件啥的。这是之前在网上看到的一个零基础到前端开发的学习路线,自己做了一个简单的技术简介、目录大纲、参考书、相关文章整理了一个不错的学习路线。因为大多数页面还是需要要定制开发的,所以开始学的时候我是从需求入手去学习页面布局。

先学页面组件吧,然后就是要学javascript语言入门,但是那个时候我还不懂什么意思,这里是我个人做的技术简介,从这个地方开始,最后才是javascript和css知识的学习,这里的根据定制类的页面来。从这里开始说说简单的页面布局有哪些布局方式吧这个是整个前端页面布局的大体框架,就是这些基本的布局方式,当时写页面简单时一定要让页面能够撑满整个布局,不然要排版起来难上加难!还有一些滚动条啊,多余的按钮要要么隐藏要么取消关闭等等布局方式,这些布局我当时是不知道怎么做,后来看大牛怎么写的。

这里有一些重要的知识点,需要注意的是一个页面要在所有可能的地方都能够做到一致的颜色,这里最好也是一个页面里面一定要有单独的颜色定义,不然页面会很乱,然后一定要有粗大和细腻的分割线,这样看着更加舒服还有line-height属性。如果这些都没有用到,自己想增加高度,可以做一些这种形状的。在配置参数时,可以看看别人有什么可以用的,一定要多练习下,这样。

php抓取网页域名(搜索引擎排列标准新手入门分析大家做SEO是干什么吗?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 79 次浏览 • 2022-03-19 21:05

初学者分析的搜索引擎排名标准

你用 SEO 做什么?就是建立网站排名,就是做百度排名,搜索引擎排名。这是我们在百度搜索中的排名。

你可以在网上搜索一个词,百度搜索可以得到很多结果,而我们要做的就是让我们的网站排名靠前。

蜘蛛的工作

为什么要谈论蜘蛛?有些人不会知道这只蜘蛛是什么。你的一个网站的内容与百度搜索有关。百度搜索引擎首先有内容吗?答案是不。网页上搜索的内容是百度搜索的吗?不,它属于我们自己的网站。那么百度是如何判断你的内容的呢?它必须根据即将到来的蜘蛛的内容“取回”,而这种“取回”称为抓取。

知识点第一,爬网【嘉峪关SEO】页面

蜘蛛爬取:就是用你的网站把这类内容取出来,最终会显示在检索结果中。

不同的搜索引擎有不同的蜘蛛,不同的人有不同的做事方式,同样的蜘蛛,不同的搜索引擎蜘蛛,不同的网页爬取方式,不同的专用工具。

搜索引擎包括百度搜索、360、Google、必应搜索、什么、搜狗搜索……

蜘蛛是如何进入您的网站的?最常见的方法是基于连接。假设一个人在走路,这个连接就是人们走的路。蜘蛛爬取,也叫爬虫,就像互联网技术中的蜘蛛网,不断的连接着,然后蜘蛛就跟随这个连接,继续去爬取你的网站,爬取你的网页,根据连接的情况进行爬取网址布局。后面文章会讲机器人,有些连接是不允许爬取的。

蜘蛛将内容带回家后,称为快照更新。

蜘蛛爬行的标准,爬行的顺序,根据连接爬行,蜘蛛爬行的深度优先策略和深度广度优先策略分别应用。

爬取的内容

蜘蛛爬行不像大家用双眼看到的,蜘蛛看到的是代码。在电脑浏览器中右键,查询网页的源代码(Ctrl u),就是蜘蛛从上到下看到和爬取的。在这段代码中,并不是所有的代码都被蜘蛛识别,有些代码是蜘蛛无法识别的,有些代码更难被蜘蛛识别。正如稍后将讨论的,这些代码对蜘蛛很友好。

蜘蛛识别连接并抓住连接。这种联系就是蜘蛛抓取的方式。没有连接,蜘蛛就无路可走。因此,URL上应该有一个链接,给蜘蛛一个爬取通道。

蜘蛛对文本内容的识别度最高。对于照片,蜘蛛的辨别度很低,但是蜘蛛可以根据图片标签的alt属性进行识别,蜘蛛根据alt属性理解图片的含义。Alt 叙述一句话,让搜索引擎图像识别。

一些网页收录视频 Flash 和 JS。这两种蜘蛛是无法区分的。iframe架构,蜘蛛没有判别力,iframe架构一般是启用另一个网页的项,常用于百度地图导航。

危害蜘蛛爬行的元素:

一是必须有管理权限才能爬取。如果你的网站只能用账号登录才能查看,那么蜘蛛没有账号,蜘蛛也不会用账号登录。然后您的内容必须登录并且必须进行管理。只能看到权限,爬虫不能爬。

另一种是网页无法访问,网页无法访问,会导致蜘蛛爬网【嘉峪关SEO】。网页无法访问的原因:1、网络服务器(室内空间)不稳定。2、404 死链接。3、网站 被劫持。

蜘蛛在哪里抓取家庭内容?---临时数据库查询(临时仓库)

为什么把它放在一个临时的数据库查询中,而不是立即存储在搜索引擎的数据库查询中呢?

经过精挑细选,蜘蛛必须选择抓取到的内容,选择最好的内容,丢弃这些浪费的内容和重复的内容,从而为客户提供最好的结果。搜索引擎的作用就是把最好的结果呈现给客户,让客户喜欢。搜索引擎会删除不好的项目和不太好的项目。没有互联网技术使用价值的页面、死链接、欺骗性页面(低质量页面)很多。节省搜索引擎工作的时间和服务器空间。

其余的好内容去哪儿了?---放入索引库

索引量:好网页的总数。索引,优质网页,查询量索引在网络搜索资源平台(百度搜索百度站长工具),后面会讲到如何使用这个专用工具。

索引后面还有一个专有名词------收录

收录 是大家参与排名的网页。检查单个网页是否为收录,该网页是否参与排名?在搜索引擎中,输入我们要查询的网页的网站地址(搜索引擎输入框不是浏览器URL文本框),如果有搜索结果就说明是也被 收录@ > 搜索过。

那么如果要查询所有被收录排名过的网站页面呢?大家使用site:网站域名示例:site:网站不收录或

只有 收录 有资格参与排名。大家平时说的[收录]等于索引。索引量超过收录(一般新建网站,索引到收录,有全过程)。索引卷小于收录(数据信息被禁止或有多个快照更新)。

百度搜索官网的名字和大家平时叫的不一样。百度搜索官网的名称是先有收录,再统计索引,收录的量超过索引量。收录 表示该网页已被蜘蛛发现并分析。索引是蜘蛛经过基本分析后发现更有意义的库的构建。

在搜索引擎中排名的步骤

爬取 --> 临时数据库查询 ---> 选择 ---> 索引 ---> 收录--> 显示排名

还有一个选择索引到收录,是从索引库文件中选择的,导致索引量和收录的量不一致。

从索引到收录再到发布,有一个排名标准---->-搜索引擎优化算法

我们在搜索引擎中搜索,这么多结果,这些显示信息在第一第二第三?它有一个标准的排列方式,俗称百度搜索优化算法,360有360优化算法,谷歌有自己的谷歌优化算法,每个搜索引擎都有自己的优化算法。

后面会出现这个搜索引擎优化算法的解读!

排名是在基本提升之上创建的。基础改进:URL精准定位、URL TDK(标题、描述、关键词)、网页布局、网站内容、客户资料信息、外链推广……这个更多在后面会有详细解读

危害百度搜索排名的因素:相关性、可信度、及时性、必要性、丰富度、[嘉峪关SEO]的流行度。--- 稍后将讨论更多项目。

热搜词 查看全部

php抓取网页域名(搜索引擎排列标准新手入门分析大家做SEO是干什么吗?)

初学者分析的搜索引擎排名标准

你用 SEO 做什么?就是建立网站排名,就是做百度排名,搜索引擎排名。这是我们在百度搜索中的排名。

你可以在网上搜索一个词,百度搜索可以得到很多结果,而我们要做的就是让我们的网站排名靠前。

蜘蛛的工作

为什么要谈论蜘蛛?有些人不会知道这只蜘蛛是什么。你的一个网站的内容与百度搜索有关。百度搜索引擎首先有内容吗?答案是不。网页上搜索的内容是百度搜索的吗?不,它属于我们自己的网站。那么百度是如何判断你的内容的呢?它必须根据即将到来的蜘蛛的内容“取回”,而这种“取回”称为抓取。

知识点第一,爬网【嘉峪关SEO】页面

蜘蛛爬取:就是用你的网站把这类内容取出来,最终会显示在检索结果中。

不同的搜索引擎有不同的蜘蛛,不同的人有不同的做事方式,同样的蜘蛛,不同的搜索引擎蜘蛛,不同的网页爬取方式,不同的专用工具。

搜索引擎包括百度搜索、360、Google、必应搜索、什么、搜狗搜索……

蜘蛛是如何进入您的网站的?最常见的方法是基于连接。假设一个人在走路,这个连接就是人们走的路。蜘蛛爬取,也叫爬虫,就像互联网技术中的蜘蛛网,不断的连接着,然后蜘蛛就跟随这个连接,继续去爬取你的网站,爬取你的网页,根据连接的情况进行爬取网址布局。后面文章会讲机器人,有些连接是不允许爬取的。

蜘蛛将内容带回家后,称为快照更新。

蜘蛛爬行的标准,爬行的顺序,根据连接爬行,蜘蛛爬行的深度优先策略和深度广度优先策略分别应用。

爬取的内容

蜘蛛爬行不像大家用双眼看到的,蜘蛛看到的是代码。在电脑浏览器中右键,查询网页的源代码(Ctrl u),就是蜘蛛从上到下看到和爬取的。在这段代码中,并不是所有的代码都被蜘蛛识别,有些代码是蜘蛛无法识别的,有些代码更难被蜘蛛识别。正如稍后将讨论的,这些代码对蜘蛛很友好。

蜘蛛识别连接并抓住连接。这种联系就是蜘蛛抓取的方式。没有连接,蜘蛛就无路可走。因此,URL上应该有一个链接,给蜘蛛一个爬取通道。

蜘蛛对文本内容的识别度最高。对于照片,蜘蛛的辨别度很低,但是蜘蛛可以根据图片标签的alt属性进行识别,蜘蛛根据alt属性理解图片的含义。Alt 叙述一句话,让搜索引擎图像识别。

一些网页收录视频 Flash 和 JS。这两种蜘蛛是无法区分的。iframe架构,蜘蛛没有判别力,iframe架构一般是启用另一个网页的项,常用于百度地图导航。

危害蜘蛛爬行的元素:

一是必须有管理权限才能爬取。如果你的网站只能用账号登录才能查看,那么蜘蛛没有账号,蜘蛛也不会用账号登录。然后您的内容必须登录并且必须进行管理。只能看到权限,爬虫不能爬。

另一种是网页无法访问,网页无法访问,会导致蜘蛛爬网【嘉峪关SEO】。网页无法访问的原因:1、网络服务器(室内空间)不稳定。2、404 死链接。3、网站 被劫持。

蜘蛛在哪里抓取家庭内容?---临时数据库查询(临时仓库)

为什么把它放在一个临时的数据库查询中,而不是立即存储在搜索引擎的数据库查询中呢?

经过精挑细选,蜘蛛必须选择抓取到的内容,选择最好的内容,丢弃这些浪费的内容和重复的内容,从而为客户提供最好的结果。搜索引擎的作用就是把最好的结果呈现给客户,让客户喜欢。搜索引擎会删除不好的项目和不太好的项目。没有互联网技术使用价值的页面、死链接、欺骗性页面(低质量页面)很多。节省搜索引擎工作的时间和服务器空间。

其余的好内容去哪儿了?---放入索引库

索引量:好网页的总数。索引,优质网页,查询量索引在网络搜索资源平台(百度搜索百度站长工具),后面会讲到如何使用这个专用工具。

索引后面还有一个专有名词------收录

收录 是大家参与排名的网页。检查单个网页是否为收录,该网页是否参与排名?在搜索引擎中,输入我们要查询的网页的网站地址(搜索引擎输入框不是浏览器URL文本框),如果有搜索结果就说明是也被 收录@ > 搜索过。

那么如果要查询所有被收录排名过的网站页面呢?大家使用site:网站域名示例:site:网站不收录或

只有 收录 有资格参与排名。大家平时说的[收录]等于索引。索引量超过收录(一般新建网站,索引到收录,有全过程)。索引卷小于收录(数据信息被禁止或有多个快照更新)。

百度搜索官网的名字和大家平时叫的不一样。百度搜索官网的名称是先有收录,再统计索引,收录的量超过索引量。收录 表示该网页已被蜘蛛发现并分析。索引是蜘蛛经过基本分析后发现更有意义的库的构建。

在搜索引擎中排名的步骤

爬取 --> 临时数据库查询 ---> 选择 ---> 索引 ---> 收录--> 显示排名

还有一个选择索引到收录,是从索引库文件中选择的,导致索引量和收录的量不一致。

从索引到收录再到发布,有一个排名标准---->-搜索引擎优化算法

我们在搜索引擎中搜索,这么多结果,这些显示信息在第一第二第三?它有一个标准的排列方式,俗称百度搜索优化算法,360有360优化算法,谷歌有自己的谷歌优化算法,每个搜索引擎都有自己的优化算法。

后面会出现这个搜索引擎优化算法的解读!

排名是在基本提升之上创建的。基础改进:URL精准定位、URL TDK(标题、描述、关键词)、网页布局、网站内容、客户资料信息、外链推广……这个更多在后面会有详细解读

危害百度搜索排名的因素:相关性、可信度、及时性、必要性、丰富度、[嘉峪关SEO]的流行度。--- 稍后将讨论更多项目。

热搜词

php抓取网页域名(织梦插件多吗?谁有织梦全套插件(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 99 次浏览 • 2022-03-19 03:13

织梦有很多插件吗?谁有织梦全套插件,织梦cms是一个独立的网站程序。今天给大家推荐的是织梦模板(内置5W套织梦cms织梦模板)和免费的织梦插件,包括:织梦@ >cms采集 插件,织梦cms伪原创 插件,织梦cms发布插件,织梦 cms主动推送插件,织梦cms自动地图插件,织梦cms聚合插件,织梦cms翻译插件等栏目插件。稍后我们将以图片的形式向您展示。大家注意看图。一键建站+行业内容采集+伪原创+主动推送到搜索引擎<

百度站长平台的同学在与站长的交流中,经常会被问到“在哪里查百度pagerank”、“百度权重是怎么计算的”等问题。

对此,百度站长平台正式发布公告:百度pagerank和百度权重不存在!

那么,百度通过什么来判断网站的值呢?因为同一个网站的值在不同的场景、不同的需求下是不同的,所以百度搜索引擎用一个固定的值来表达网站的值既不技术也不严谨。百度搜索引擎确实有衡量网站价值的评分系统,由近百种策略组成,但评分是动态的,即同一个网站在不同场景下获得的评分和不同的需求是不同的。全都一样。

此外,我们提醒广大站长不要相信任何第三方组织或个人在百度提供的所谓网站体重信息。如前所述,百度搜索引擎对网站值的评价是动态的,任何机构或个人提供的分数只是针对单一场景和需求进行计算和估算的。对于网站的运营工作没有实际的指导意义。

关于百度等搜索引擎的工作原理,我们其实已经讨论了很多,但是随着技术的进步和互联网行业的发展,各种搜索引擎都发生了很大的变化,而且这些变化是很快的。我们设计这一章的目的不仅是为了从官方的角度发出一些声音,纠正之前的一些误解,同时也希望不时更新内容,与百度搜索引擎的发展保持同步,以及为站长带来最新的、百度搜索引擎开发。高度相关的信息。本章主要内容分为四章,即:爬取和建库;检索和分类;外部投票;结果显示。

蜘蛛爬行系统的基本框架

随着互联网信息的爆炸式增长,如何有效地获取和应用这些信息是搜索引擎工作的首要环节。数据爬取系统作为整个搜索系统的上游,主要负责互联网信息的采集、存储和更新。它像蜘蛛一样在网络中爬行,因此通常被称为“蜘蛛”。比如我们常用的几种常见的搜索引擎蜘蛛叫做:Baiduspdier、Googlebot、搜狗网络蜘蛛等。

蜘蛛爬取系统是搜索引擎数据来源的重要保障。如果把网络理解为一个有向图,那么蜘蛛的工作过程可以看成是对这个有向图的遍历。从一些重要的种子URL开始,通过页面上的超链接关系,不时发现新的URL并进行爬取,尽可能多地爬取有价值的网页。对于百度这样的大型爬虫系统,由于网页随时都有可能被修改、删除或出现新的超链接,因此需要不断更新蜘蛛过去爬过的页面,维护一个URL库和页面库。

下图是蜘蛛爬取系统的基本框架,包括链接存储系统、链接选择系统、dns解析服务系统、爬取调度系统、网页分析系统、链接提取系统、链接分析系统、网页存储系统。百度蜘蛛通过本系统的配合完成对互联网页面的爬取。

蜘蛛爬行系统的基本框架图

百度蜘蛛主要是爬取策略类型

上图看似简单,但实际上百度蜘蛛在爬取过程中面临着一个超级复杂的网络环境。为了让系统尽可能多的抢到有价值的资源,在坚持页面在系统和实际环境中的发散的同时,不会给网站的体验带来压力,会设计一个各种复杂的抓取策略。下面是最简单的介绍:

1、获取友好信息

海量的互联网资源要求爬虫系统尽可能高效地利用带宽,在有限的硬件和带宽资源下尽可能多地抓取有价值的资源。这产生了另一个问题。消耗捕获的 网站 的带宽会产生访问压力。如果级别太高,将直接影响捕获到的网站的正常用户访问行为。因此,在爬取过程中,必须停止一定的爬取压力控制,以达到在不影响网站正常用户访问的情况下尽可能多地抓取有价值资源的目的。

通常,最基本的是基于ip的压力控制。这是因为如果是基于域名的话,可能会出现一个域名对应多个IP(很多大网站)或者多个域名对应同一个IP(小网站共享)的问题知识产权)。在实践中,压力分配控制往往是根据ip和域名的各种条件来实现的。同时,站长平台也推出了压力响应工具。站长可以手动将抓取压力分配给自己网站。此时百度蜘蛛会根据站长的要求优先停止抓压控制。

对同一站点的爬取速度控制一般分为两类:一类是一段时间内的爬取频率;另一种是一段时间内的爬行流量。同一个站点在不同时间的爬取速度也会不同。例如,在夜深人静、静月、暗风和大风中,爬行可能会更快。它还取决于特定的站点类型。主要思路是错开正常用户访问的高峰,不时调整。对于不同的站点,也需要不同的爬取率。

2、常用的fetch返回码表示

几个百度支持的返回码的简单介绍:

1)最常见的404代表“NOT FOUND”,表示网页已经失效,通常会从库中删除。同时,如果蜘蛛在短期内再次找到这个url,则不会被抓取;

2)503代表“Service Unavailable”,表示网页暂时不可用,通常网站暂时关闭,带宽受限等会导致这种情况。对于网页返回的503状态码,百度蜘蛛不会直接删除这个url,会在短时间内多次访问。如果网页已经恢复,会正常爬取;如果它继续返回 503,那么这个 url 仍然会被访问。我认为这是一个无效链接并将其从库中删除。

3)403 代表“Forbidden”,表示当前禁止访问该网页。如果是新的url,蜘蛛暂时不会抓取,短期内也会多次访问;如果是已有的收录url,则不会直接删除,短期内也会多次访问。如果网页正常访问,则正常爬取;如果仍然禁止访问,则此 url 也将被视为无效链接,将从库中删除。

4)301 表示“永久移动”,表示页面重定向到新的 url。当遇到网站迁移、域名变更、网站改版等情况时,建议使用301返回码,并使用站长平台的网站改版工具,以减少因网站造成的流量损失修订。

3、识别多个 url 重定向

由于各种原因,互联网中的一部分网页出现了url重定向状态。为了正常抓取这部分资源,请求蜘蛛停止对url重定向的识别和判别,同时避免作弊。重定向可以分为三类:http 30x 重定向、元刷新重定向和 js 重定向。此外,百度还支持规范标签,可以认为是间接重定向。

4、获取优先级分配

由于互联网资源范围的巨大而迅速的变化,搜索引擎不可能将它们全部抓取并保持它们与合理的更新保持一致。因此,这就需要爬取系统设计一套合理的爬取优先级。层级分配策略。主要包括:深度优先遍历策略、广度优先遍历策略、pr优先策略、反链策略、社交分享引导策略等,每种策略都有自己的优缺点。在实践中,往往会单独使用多种策略,以达到最佳的抓取效果。

5、 重复的url过滤

在爬取过程中,蜘蛛需要判断一个页面之前是否被爬过,如果没有被爬过,则停止对该页面的爬取,并将其放入被爬取的URL集合中。判断是否被爬取,最重要的是快速查找对比,同时涉及到url规范化识别。例如,一个url收录大量无效参数,但实际上是同一个页面,会被认为是同一个url。看着。

6、访问暗网数据

互联网上有很多暂时无法被搜索引擎捕获的数据,称为暗网数据。一方面,大量网站的大量数据存在于网络数据库中,蜘蛛很难通过爬取网页获取完整的内容;以此类推,也会导致搜索引擎无法抓取。目前,获取暗网数据的主要思路还是通过开放平台使用数据提交进行处理,如“百度站长平台”、“百度开放平台”等。

7、抓住反作弊者

Spider在爬取过程中经常会遇到所谓的爬虫黑洞或者被大量低质量页面干扰,这就需要在爬虫系统中设计一套完整的爬虫防作弊系统。比如分析url特征,分析页面大小和内容,分析爬取范围对应的站点范围等等。 查看全部

php抓取网页域名(织梦插件多吗?谁有织梦全套插件(组图))

织梦有很多插件吗?谁有织梦全套插件,织梦cms是一个独立的网站程序。今天给大家推荐的是织梦模板(内置5W套织梦cms织梦模板)和免费的织梦插件,包括:织梦@ >cms采集 插件,织梦cms伪原创 插件,织梦cms发布插件,织梦 cms主动推送插件,织梦cms自动地图插件,织梦cms聚合插件,织梦cms翻译插件等栏目插件。稍后我们将以图片的形式向您展示。大家注意看图。一键建站+行业内容采集+伪原创+主动推送到搜索引擎<

百度站长平台的同学在与站长的交流中,经常会被问到“在哪里查百度pagerank”、“百度权重是怎么计算的”等问题。

对此,百度站长平台正式发布公告:百度pagerank和百度权重不存在!

那么,百度通过什么来判断网站的值呢?因为同一个网站的值在不同的场景、不同的需求下是不同的,所以百度搜索引擎用一个固定的值来表达网站的值既不技术也不严谨。百度搜索引擎确实有衡量网站价值的评分系统,由近百种策略组成,但评分是动态的,即同一个网站在不同场景下获得的评分和不同的需求是不同的。全都一样。

此外,我们提醒广大站长不要相信任何第三方组织或个人在百度提供的所谓网站体重信息。如前所述,百度搜索引擎对网站值的评价是动态的,任何机构或个人提供的分数只是针对单一场景和需求进行计算和估算的。对于网站的运营工作没有实际的指导意义。

关于百度等搜索引擎的工作原理,我们其实已经讨论了很多,但是随着技术的进步和互联网行业的发展,各种搜索引擎都发生了很大的变化,而且这些变化是很快的。我们设计这一章的目的不仅是为了从官方的角度发出一些声音,纠正之前的一些误解,同时也希望不时更新内容,与百度搜索引擎的发展保持同步,以及为站长带来最新的、百度搜索引擎开发。高度相关的信息。本章主要内容分为四章,即:爬取和建库;检索和分类;外部投票;结果显示。

蜘蛛爬行系统的基本框架

随着互联网信息的爆炸式增长,如何有效地获取和应用这些信息是搜索引擎工作的首要环节。数据爬取系统作为整个搜索系统的上游,主要负责互联网信息的采集、存储和更新。它像蜘蛛一样在网络中爬行,因此通常被称为“蜘蛛”。比如我们常用的几种常见的搜索引擎蜘蛛叫做:Baiduspdier、Googlebot、搜狗网络蜘蛛等。

蜘蛛爬取系统是搜索引擎数据来源的重要保障。如果把网络理解为一个有向图,那么蜘蛛的工作过程可以看成是对这个有向图的遍历。从一些重要的种子URL开始,通过页面上的超链接关系,不时发现新的URL并进行爬取,尽可能多地爬取有价值的网页。对于百度这样的大型爬虫系统,由于网页随时都有可能被修改、删除或出现新的超链接,因此需要不断更新蜘蛛过去爬过的页面,维护一个URL库和页面库。

下图是蜘蛛爬取系统的基本框架,包括链接存储系统、链接选择系统、dns解析服务系统、爬取调度系统、网页分析系统、链接提取系统、链接分析系统、网页存储系统。百度蜘蛛通过本系统的配合完成对互联网页面的爬取。

蜘蛛爬行系统的基本框架图

百度蜘蛛主要是爬取策略类型

上图看似简单,但实际上百度蜘蛛在爬取过程中面临着一个超级复杂的网络环境。为了让系统尽可能多的抢到有价值的资源,在坚持页面在系统和实际环境中的发散的同时,不会给网站的体验带来压力,会设计一个各种复杂的抓取策略。下面是最简单的介绍:

1、获取友好信息

海量的互联网资源要求爬虫系统尽可能高效地利用带宽,在有限的硬件和带宽资源下尽可能多地抓取有价值的资源。这产生了另一个问题。消耗捕获的 网站 的带宽会产生访问压力。如果级别太高,将直接影响捕获到的网站的正常用户访问行为。因此,在爬取过程中,必须停止一定的爬取压力控制,以达到在不影响网站正常用户访问的情况下尽可能多地抓取有价值资源的目的。

通常,最基本的是基于ip的压力控制。这是因为如果是基于域名的话,可能会出现一个域名对应多个IP(很多大网站)或者多个域名对应同一个IP(小网站共享)的问题知识产权)。在实践中,压力分配控制往往是根据ip和域名的各种条件来实现的。同时,站长平台也推出了压力响应工具。站长可以手动将抓取压力分配给自己网站。此时百度蜘蛛会根据站长的要求优先停止抓压控制。

对同一站点的爬取速度控制一般分为两类:一类是一段时间内的爬取频率;另一种是一段时间内的爬行流量。同一个站点在不同时间的爬取速度也会不同。例如,在夜深人静、静月、暗风和大风中,爬行可能会更快。它还取决于特定的站点类型。主要思路是错开正常用户访问的高峰,不时调整。对于不同的站点,也需要不同的爬取率。

2、常用的fetch返回码表示

几个百度支持的返回码的简单介绍:

1)最常见的404代表“NOT FOUND”,表示网页已经失效,通常会从库中删除。同时,如果蜘蛛在短期内再次找到这个url,则不会被抓取;

2)503代表“Service Unavailable”,表示网页暂时不可用,通常网站暂时关闭,带宽受限等会导致这种情况。对于网页返回的503状态码,百度蜘蛛不会直接删除这个url,会在短时间内多次访问。如果网页已经恢复,会正常爬取;如果它继续返回 503,那么这个 url 仍然会被访问。我认为这是一个无效链接并将其从库中删除。

3)403 代表“Forbidden”,表示当前禁止访问该网页。如果是新的url,蜘蛛暂时不会抓取,短期内也会多次访问;如果是已有的收录url,则不会直接删除,短期内也会多次访问。如果网页正常访问,则正常爬取;如果仍然禁止访问,则此 url 也将被视为无效链接,将从库中删除。

4)301 表示“永久移动”,表示页面重定向到新的 url。当遇到网站迁移、域名变更、网站改版等情况时,建议使用301返回码,并使用站长平台的网站改版工具,以减少因网站造成的流量损失修订。

3、识别多个 url 重定向

由于各种原因,互联网中的一部分网页出现了url重定向状态。为了正常抓取这部分资源,请求蜘蛛停止对url重定向的识别和判别,同时避免作弊。重定向可以分为三类:http 30x 重定向、元刷新重定向和 js 重定向。此外,百度还支持规范标签,可以认为是间接重定向。

4、获取优先级分配

由于互联网资源范围的巨大而迅速的变化,搜索引擎不可能将它们全部抓取并保持它们与合理的更新保持一致。因此,这就需要爬取系统设计一套合理的爬取优先级。层级分配策略。主要包括:深度优先遍历策略、广度优先遍历策略、pr优先策略、反链策略、社交分享引导策略等,每种策略都有自己的优缺点。在实践中,往往会单独使用多种策略,以达到最佳的抓取效果。

5、 重复的url过滤

在爬取过程中,蜘蛛需要判断一个页面之前是否被爬过,如果没有被爬过,则停止对该页面的爬取,并将其放入被爬取的URL集合中。判断是否被爬取,最重要的是快速查找对比,同时涉及到url规范化识别。例如,一个url收录大量无效参数,但实际上是同一个页面,会被认为是同一个url。看着。

6、访问暗网数据

互联网上有很多暂时无法被搜索引擎捕获的数据,称为暗网数据。一方面,大量网站的大量数据存在于网络数据库中,蜘蛛很难通过爬取网页获取完整的内容;以此类推,也会导致搜索引擎无法抓取。目前,获取暗网数据的主要思路还是通过开放平台使用数据提交进行处理,如“百度站长平台”、“百度开放平台”等。

7、抓住反作弊者

Spider在爬取过程中经常会遇到所谓的爬虫黑洞或者被大量低质量页面干扰,这就需要在爬虫系统中设计一套完整的爬虫防作弊系统。比如分析url特征,分析页面大小和内容,分析爬取范围对应的站点范围等等。

php抓取网页域名(php抓取网页域名,转存到本地php解析页面返回数据)

网站优化 • 优采云 发表了文章 • 0 个评论 • 87 次浏览 • 2022-03-17 13:02

php抓取网页域名,转存到本地,php下载域名,php解析生成页面,解析页面返回数据,asp下载页面,解析页面,下载文件,回头解析asp返回数据

中间少了一步,先抓取网站,把页面信息提取出来,比如header,title,url等信息,存到excel里面,

这个问题和网站是一个类型的吗?把网站解析成asp能直接打开的页面,asp提取页面里的源码放到php文件里用php程序解析,如果是网站后台这样的页面,

两种方法1是爬虫,爬出asp页面,打开把asp页面信息粘贴到浏览器解析页面即可。2是mysql数据库,把页面信息写入数据库,

可以试一下posixbrowser(中文名是posix浏览器),最好是最好是收费的,免费的对于小型网站太不人性化了。posix浏览器可以放到控制台,运行后台javaweb服务器,一行代码解析出来页面里的所有代码。

php的我没用过,目前正在用asp的.抓取网页是网页数据库记录下来,asp读取数据库,再到php里读取数据.

我也想弄,可能我没有技术储备,只能在实践中去体会。

这个就算小网站,看了你的需求不难,原因是现在的开发基本都是数据库直接抓取对方的数据,如果网站有个js模块,一般会内嵌到js模块,直接抓取js模块是不存在这样的问题的,可能楼主是遇到要抓数据库数据,你可以先直接获取数据库信息,然后用的apache服务器抓取,可以稍微完善一点。 查看全部

php抓取网页域名(php抓取网页域名,转存到本地php解析页面返回数据)

php抓取网页域名,转存到本地,php下载域名,php解析生成页面,解析页面返回数据,asp下载页面,解析页面,下载文件,回头解析asp返回数据

中间少了一步,先抓取网站,把页面信息提取出来,比如header,title,url等信息,存到excel里面,

这个问题和网站是一个类型的吗?把网站解析成asp能直接打开的页面,asp提取页面里的源码放到php文件里用php程序解析,如果是网站后台这样的页面,

两种方法1是爬虫,爬出asp页面,打开把asp页面信息粘贴到浏览器解析页面即可。2是mysql数据库,把页面信息写入数据库,

可以试一下posixbrowser(中文名是posix浏览器),最好是最好是收费的,免费的对于小型网站太不人性化了。posix浏览器可以放到控制台,运行后台javaweb服务器,一行代码解析出来页面里的所有代码。

php的我没用过,目前正在用asp的.抓取网页是网页数据库记录下来,asp读取数据库,再到php里读取数据.

我也想弄,可能我没有技术储备,只能在实践中去体会。

这个就算小网站,看了你的需求不难,原因是现在的开发基本都是数据库直接抓取对方的数据,如果网站有个js模块,一般会内嵌到js模块,直接抓取js模块是不存在这样的问题的,可能楼主是遇到要抓数据库数据,你可以先直接获取数据库信息,然后用的apache服务器抓取,可以稍微完善一点。

php抓取网页域名(抓包64githubreverse-php-base64-php-framework.io/connectus64你试试)

网站优化 • 优采云 发表了文章 • 0 个评论 • 101 次浏览 • 2022-03-09 15:00

php抓取网页域名信息githubreverse--php-base64。可以抓到网页上的域名的每一个字段。当然,github已经给php的每一个用户解析到了,只是分析这些页面需要定制一些参数,才能获取到真正的域名。

reverse/php-base64·github

reverse-php-base64

你试试阿里云php抓包?可以反向代理

https--http

php--curl可以抓到每一次调用的http请求的地址

如果是在http协议中的,可以用curl抓包。再用reversebase64转码。

去github上搜一下reversebase64。当然这个库和swift并不合适,可以换一个自己喜欢的。

php的http请求中可以包含解析http域名参数的http头部,里面有可以解析域名的参数就可以反向代理去抓包了。当然这种情况也只能是有一定的抓包基础或者已经对抓包操作很熟练的人才能做到。

githubreverse-php-base64githubreverse-php-base64-php-framework.github.io/connectus.github.io/reverse-php-base64

每次请求包含解析http域名参数的http头部,是能抓取到解析参数。

可以去github看看@warvan的admin/php-base64-checker

用php-http-multi-cookie去抓包, 查看全部

php抓取网页域名(抓包64githubreverse-php-base64-php-framework.io/connectus64你试试)

php抓取网页域名信息githubreverse--php-base64。可以抓到网页上的域名的每一个字段。当然,github已经给php的每一个用户解析到了,只是分析这些页面需要定制一些参数,才能获取到真正的域名。

reverse/php-base64·github

reverse-php-base64

你试试阿里云php抓包?可以反向代理

https--http

php--curl可以抓到每一次调用的http请求的地址

如果是在http协议中的,可以用curl抓包。再用reversebase64转码。

去github上搜一下reversebase64。当然这个库和swift并不合适,可以换一个自己喜欢的。

php的http请求中可以包含解析http域名参数的http头部,里面有可以解析域名的参数就可以反向代理去抓包了。当然这种情况也只能是有一定的抓包基础或者已经对抓包操作很熟练的人才能做到。

githubreverse-php-base64githubreverse-php-base64-php-framework.github.io/connectus.github.io/reverse-php-base64

每次请求包含解析http域名参数的http头部,是能抓取到解析参数。

可以去github看看@warvan的admin/php-base64-checker

用php-http-multi-cookie去抓包,

php抓取网页域名(php抓取网页域名的的步骤:1.下载phpurllib2。)

网站优化 • 优采云 发表了文章 • 0 个评论 • 98 次浏览 • 2022-03-03 08:05

php抓取网页域名的的步骤:1.下载phpurllib2。phpurllib2是一个php的通用url对象,可以与php处理大量文件的访问,例如从各种url地址生成、解析或传输格式化数据。2.下载网页。使用浏览器下载网页的数据,可以使用fiddler或sqlmap抓取。下载一个解析网页数据一般来说比较麻烦,因为下载速度不是很快,所以可以考虑爬虫类的网站的开发或者其他数据抓取类的网站。

例如github-android-webmanager/dbhihupsers(github):androiddataapigenerator,python,java,php,javascript,,phponlineforeverybody!.javascriptsimplefortheweb3.接下来就是抓取数据。

下载数据后,我们要修改服务器,需要去官网或cookie去改cookie,下载urllib2库。例如cookie=@@#*+*yyxs0d4whxfct1j0zq0,修改@post_method=nullorcookie=@@#*+*yyxs0d4whxfct1j0zq04.修改配置服务器代理。

可以通过修改服务器配置文件config.php例如:然后修改修改index.php中的useragent,例如@post_method=nullor修改index.php文件,useragent如下图所示:修改代理ip地址。例如config.php中aliasget_server_ip='2.8.10.1'externaladdress:0.0.0.0或get_server_ip='3.9.6.0'externaladdress:''服务器ip地址为:/%world%world用户名::/%world%world密码:::php是未开源的,安全软件都抓取不了,所以要抓取所有数据都要开源,dataignore即可。以上是下载页面的步骤。 查看全部

php抓取网页域名(php抓取网页域名的的步骤:1.下载phpurllib2。)

php抓取网页域名的的步骤:1.下载phpurllib2。phpurllib2是一个php的通用url对象,可以与php处理大量文件的访问,例如从各种url地址生成、解析或传输格式化数据。2.下载网页。使用浏览器下载网页的数据,可以使用fiddler或sqlmap抓取。下载一个解析网页数据一般来说比较麻烦,因为下载速度不是很快,所以可以考虑爬虫类的网站的开发或者其他数据抓取类的网站。

例如github-android-webmanager/dbhihupsers(github):androiddataapigenerator,python,java,php,javascript,,phponlineforeverybody!.javascriptsimplefortheweb3.接下来就是抓取数据。

下载数据后,我们要修改服务器,需要去官网或cookie去改cookie,下载urllib2库。例如cookie=@@#*+*yyxs0d4whxfct1j0zq0,修改@post_method=nullorcookie=@@#*+*yyxs0d4whxfct1j0zq04.修改配置服务器代理。

可以通过修改服务器配置文件config.php例如:然后修改修改index.php中的useragent,例如@post_method=nullor修改index.php文件,useragent如下图所示:修改代理ip地址。例如config.php中aliasget_server_ip='2.8.10.1'externaladdress:0.0.0.0或get_server_ip='3.9.6.0'externaladdress:''服务器ip地址为:/%world%world用户名::/%world%world密码:::php是未开源的,安全软件都抓取不了,所以要抓取所有数据都要开源,dataignore即可。以上是下载页面的步骤。

php抓取网页域名的报价:.php视情况升级框架

网站优化 • 优采云 发表了文章 • 0 个评论 • 90 次浏览 • 2022-09-05 22:02

php抓取网页域名的报价:.php楼主你查一下搜狗.php做的网站报价..php视情况升级php框架,比如用hibernate.当然hibernate也是不错的

企业最好的选择是laravel\ci\php+mysql/smarty...其次是php7和node.js。web只是一个小部分,不要纠结这些。

swoole

php+apache+mysql。

用php+mysql好多数据是比较靠谱的.

还有yii吗?

laravel,这个开源框架还是很好用的,laravel就是基于php5的mvc设计,基于web开发相对比较容易。

针对国内现状,可以建议选择《图灵教育|学习型开发,从这个开始》系列课程,中心主要讲解企业应用系统的开发。课程的主要目的是为那些缺乏工程实践的学生和企业技术专家提供课程。这个系列由thoughtworks全球技术总监李典通过大量的项目开发经验讲解企业应用系统开发的基本概念、思想和技术。课程主要面向:企业级应用系统开发过程中遇到的技术瓶颈、企业应用开发中技术的成本、开发中出现的问题、学习能力的培养等。

讲师团队来自阿里、腾讯、百度、海尔、360、腾讯等知名企业。从以下4点上对企业应用系统的开发做详细讲解:php语言基础,可以看李典老师在讲解php时,带领大家掌握6个核心:nofile、文件上传、文件读写、lbs定位、文件权限、mongodb,用来解决网站不安全的问题。nginx反向代理,提高系统带宽性。

mysql数据库,提高系统的性能。redis缓存,提高系统的性能。webserver,解决网站速度慢。解决企业应用程序性能问题的一个较有效方法,就是采用分布式、虚拟化等高性能服务器,使其代价低于并发量,相当于将cpu资源划分为很多资源池,这样实现资源的互相隔离。以下是我自己学习时整理的“基于php语言的整站架构”。 查看全部

php抓取网页域名的报价:.php视情况升级框架

php抓取网页域名的报价:.php楼主你查一下搜狗.php做的网站报价..php视情况升级php框架,比如用hibernate.当然hibernate也是不错的

企业最好的选择是laravel\ci\php+mysql/smarty...其次是php7和node.js。web只是一个小部分,不要纠结这些。

swoole

php+apache+mysql。

用php+mysql好多数据是比较靠谱的.

还有yii吗?

laravel,这个开源框架还是很好用的,laravel就是基于php5的mvc设计,基于web开发相对比较容易。

针对国内现状,可以建议选择《图灵教育|学习型开发,从这个开始》系列课程,中心主要讲解企业应用系统的开发。课程的主要目的是为那些缺乏工程实践的学生和企业技术专家提供课程。这个系列由thoughtworks全球技术总监李典通过大量的项目开发经验讲解企业应用系统开发的基本概念、思想和技术。课程主要面向:企业级应用系统开发过程中遇到的技术瓶颈、企业应用开发中技术的成本、开发中出现的问题、学习能力的培养等。

讲师团队来自阿里、腾讯、百度、海尔、360、腾讯等知名企业。从以下4点上对企业应用系统的开发做详细讲解:php语言基础,可以看李典老师在讲解php时,带领大家掌握6个核心:nofile、文件上传、文件读写、lbs定位、文件权限、mongodb,用来解决网站不安全的问题。nginx反向代理,提高系统带宽性。

mysql数据库,提高系统的性能。redis缓存,提高系统的性能。webserver,解决网站速度慢。解决企业应用程序性能问题的一个较有效方法,就是采用分布式、虚拟化等高性能服务器,使其代价低于并发量,相当于将cpu资源划分为很多资源池,这样实现资源的互相隔离。以下是我自己学习时整理的“基于php语言的整站架构”。

php抓取网页域名可以使用正则表达式匹配。匹配的好处

网站优化 • 优采云 发表了文章 • 0 个评论 • 88 次浏览 • 2022-08-16 21:01

php抓取网页域名可以使用正则表达式匹配。正则表达式匹配的好处在于它简单快捷,没有计算机编程基础的人也能根据正则表达式有很快的查找、匹配和循环计算。我看有人发过这个网址,应该算比较详细了。网址:php抓取天猫网站。如果需要对比评价什么的,用js自身可以转换。目前经常用到。

php的话,可以用正则表达式来抓取天猫评价。正则表达式是一种语法,可以匹配任何符合正则表达式的字符串。要获取评价的话,可以在天猫右侧,找到评价的链接,解析出评价列表的php代码。

自己写爬虫:*使用框架:requests或者beautifulsoup库*手动爬取:拿手机端为例:selenium+androidstudio,这个属于开发工具,具体是使用这个工具的php爬虫,还是自己写的爬虫,

java可以先用requests来抓取,selenium是要用到androidstudio才可以使用。你可以先理一下业务逻辑,再找一下框架,其实没太大的区别。

php一般可以用requests库爬取,你可以根据业务逻辑分析需要的评价,这样可以方便google、百度、bing、搜狗等等这些搜索引擎抓取并识别评价中的商品,从而得到商品数据。你完全可以通过定制的思维完成获取评价业务逻辑的整合与分析。 查看全部

php抓取网页域名可以使用正则表达式匹配。匹配的好处

php抓取网页域名可以使用正则表达式匹配。正则表达式匹配的好处在于它简单快捷,没有计算机编程基础的人也能根据正则表达式有很快的查找、匹配和循环计算。我看有人发过这个网址,应该算比较详细了。网址:php抓取天猫网站。如果需要对比评价什么的,用js自身可以转换。目前经常用到。

php的话,可以用正则表达式来抓取天猫评价。正则表达式是一种语法,可以匹配任何符合正则表达式的字符串。要获取评价的话,可以在天猫右侧,找到评价的链接,解析出评价列表的php代码。

自己写爬虫:*使用框架:requests或者beautifulsoup库*手动爬取:拿手机端为例:selenium+androidstudio,这个属于开发工具,具体是使用这个工具的php爬虫,还是自己写的爬虫,

java可以先用requests来抓取,selenium是要用到androidstudio才可以使用。你可以先理一下业务逻辑,再找一下框架,其实没太大的区别。

php一般可以用requests库爬取,你可以根据业务逻辑分析需要的评价,这样可以方便google、百度、bing、搜狗等等这些搜索引擎抓取并识别评价中的商品,从而得到商品数据。你完全可以通过定制的思维完成获取评价业务逻辑的整合与分析。

【外链建设】测试了1500个hao123推荐的网站,只为挖掘发能外链的DZ论坛

网站优化 • 优采云 发表了文章 • 0 个评论 • 99 次浏览 • 2022-06-19 03:20

点击上面“蓝字”关注!

虽然已经过了外链为皇的时代,但外链在新站建设、重点关键词排名等工作场景中依然占据着很重要的位置。

因为我工作后,大部分的时间在做品牌SEO,没有积攒什么外链资源;这次要梳理SEO技术,我的新博客也需要扩大外链的广泛度。所以前期会在积累外链资源先发力一些。

首先说下为什么从hao123上找外链!网络上的网址千千万,搜索引擎蜘蛛抓取网络中的内容总要有个起点,这个起点就叫“种子站点”。hao123这类网站就是优质的种子站点。关于种子站点的具体含义,可以参考《走进搜索引擎》。

目前论坛外链作用不大,而且很多论坛已经不能发了,这次只是做一个初步尝试。后续会开拓更多类型平台中的外链资源,如目录站点、b2b网站外链等,也会逐步分析我挖掘外链资源的方法和外链建设的策略。

第一步,获取所有hao123推荐链接

hao123论坛推荐页面:

获取本页面所有的网站,共发现212个。

(如有需要,可以加我的微信或者加入我的知识星球)

第二步,获取所有hao123推荐链接的友情链接,0层,1层

利用上一步获得的212个网站,批量查询所有网站的友情链接,并保存。

本次共获得网站数量1452个,平均每个网站的外链数量是:6.8个。过程中,发现很多网站已经不能访问,只能删除;还有大量网站是同一个域名出现多个二、三级域名。也只能通过程序删除,最终剩下1007个站点。提取根域名的方法还比较麻烦,感兴趣的可以看这里python提取根域名(博客中查看)。

第三部:检查网站SEO数据

本来第三步打算开始检测是否是DZ程序的,但后面发现很多网站的权重已经是0了,根本没有挖掘意义,就开发了工具,通过爱站的API批量查了网站的SEO数据。还好API调取的价格合理,没花多少钱。

(1007个网站的百度权重分布图)

(如有需要,可以加我的微信或者加入我的知识星球)

通过数据可以发现了几个特征:

第四步,判断所有 hao123推荐链接的友情链接站的程序是否是DZ,是否可以正常打开等

通过上一步的筛选,挖掘到百度权重1~8的网站数量489个;进一步判断网站是否为论坛,是否可以发帖。

工具的基本思路是:

程序分析后发现206个DZ论坛。

(如有需要,可以加我的微信或者加入我的知识星球)

第五步:监测是否可以发外链

这一步程序化存在很大问题,每个论坛的模板不同,首页展示方式不同,很难程序判断。只能人工。

人工检测方式如下:

总结:这次共查到有效DZ论坛206个, 目前查了50多个,发现其他人发外链痕迹的网站有10多个。还算不错。

目前程序还在进行二次开发;会把挖掘高权重论坛进行高度程序化,挖掘更多优质的可以发外链的DZ论坛。后期会在我的博客和公众号公布。

如果需要这次的数据,可以加我的微信或者加入我的免费知识星球获取:

研究搜索引擎原理、用数据说话,不做经验派 查看全部

【外链建设】测试了1500个hao123推荐的网站,只为挖掘发能外链的DZ论坛

点击上面“蓝字”关注!

虽然已经过了外链为皇的时代,但外链在新站建设、重点关键词排名等工作场景中依然占据着很重要的位置。

因为我工作后,大部分的时间在做品牌SEO,没有积攒什么外链资源;这次要梳理SEO技术,我的新博客也需要扩大外链的广泛度。所以前期会在积累外链资源先发力一些。

首先说下为什么从hao123上找外链!网络上的网址千千万,搜索引擎蜘蛛抓取网络中的内容总要有个起点,这个起点就叫“种子站点”。hao123这类网站就是优质的种子站点。关于种子站点的具体含义,可以参考《走进搜索引擎》。

目前论坛外链作用不大,而且很多论坛已经不能发了,这次只是做一个初步尝试。后续会开拓更多类型平台中的外链资源,如目录站点、b2b网站外链等,也会逐步分析我挖掘外链资源的方法和外链建设的策略。

第一步,获取所有hao123推荐链接

hao123论坛推荐页面:

获取本页面所有的网站,共发现212个。

(如有需要,可以加我的微信或者加入我的知识星球)

第二步,获取所有hao123推荐链接的友情链接,0层,1层

利用上一步获得的212个网站,批量查询所有网站的友情链接,并保存。

本次共获得网站数量1452个,平均每个网站的外链数量是:6.8个。过程中,发现很多网站已经不能访问,只能删除;还有大量网站是同一个域名出现多个二、三级域名。也只能通过程序删除,最终剩下1007个站点。提取根域名的方法还比较麻烦,感兴趣的可以看这里python提取根域名(博客中查看)。

第三部:检查网站SEO数据

本来第三步打算开始检测是否是DZ程序的,但后面发现很多网站的权重已经是0了,根本没有挖掘意义,就开发了工具,通过爱站的API批量查了网站的SEO数据。还好API调取的价格合理,没花多少钱。

(1007个网站的百度权重分布图)

(如有需要,可以加我的微信或者加入我的知识星球)

通过数据可以发现了几个特征:

第四步,判断所有 hao123推荐链接的友情链接站的程序是否是DZ,是否可以正常打开等

通过上一步的筛选,挖掘到百度权重1~8的网站数量489个;进一步判断网站是否为论坛,是否可以发帖。

工具的基本思路是:

程序分析后发现206个DZ论坛。

(如有需要,可以加我的微信或者加入我的知识星球)

第五步:监测是否可以发外链

这一步程序化存在很大问题,每个论坛的模板不同,首页展示方式不同,很难程序判断。只能人工。

人工检测方式如下:

总结:这次共查到有效DZ论坛206个, 目前查了50多个,发现其他人发外链痕迹的网站有10多个。还算不错。

目前程序还在进行二次开发;会把挖掘高权重论坛进行高度程序化,挖掘更多优质的可以发外链的DZ论坛。后期会在我的博客和公众号公布。

如果需要这次的数据,可以加我的微信或者加入我的免费知识星球获取:

研究搜索引擎原理、用数据说话,不做经验派

php抓取网页域名这个网站是免费的,服务器一年一交

网站优化 • 优采云 发表了文章 • 0 个评论 • 77 次浏览 • 2022-06-18 10:02

php抓取网页域名这个网站是免费的,免费的意思是域名免费,服务器一年一交。工具是phpstorm环境搭建:1.首先进入网站:/2.修改浏览器:443http代理以为qq号:443就像这样:3.进入浏览器,工具栏选phpstorm4.鼠标右键项目目录下的main.php,不要在目录中!不要在目录中!不要在目录中!5.输入命令行:phpexecl;//可以输入任何前缀都可以,不要在命令行输入前缀(括号中的路径)6.代码完成后,会生成phpstorm.conf文件这样就可以通过phpstorm导入了。

看视频,读书是为了去理解,

我觉得知乎不太适合提问,更适合分享,目前的我走过了想去知乎学习或者去百度搜索相关问题的整个过程,这是我接触到知乎的第一步,现在我对知乎产生了依赖,

看视频,看php教程,

看视频,看电子书,百度php贴吧或者相关论坛(博客,社区)。

手机备忘录做笔记啊。写下遇到的问题的解决办法。

理论好,学起来容易很多,真正掌握php有点难,必须刷题,然后多敲。

既然已经学会php了,应该了解,网页的加载原理了吧,w3c在这方面有太多的资料了,简单说就是让页面加载一些数据或者服务,等数据读取完了把这些加载后的数据,转换成我们需要的动态的东西。数据编码。等等等等。不管你后端的处理多牛逼,服务器的处理多牛逼,php很难实现对所有的后端数据展示逻辑的灵活处理。 查看全部

php抓取网页域名这个网站是免费的,服务器一年一交

php抓取网页域名这个网站是免费的,免费的意思是域名免费,服务器一年一交。工具是phpstorm环境搭建:1.首先进入网站:/2.修改浏览器:443http代理以为qq号:443就像这样:3.进入浏览器,工具栏选phpstorm4.鼠标右键项目目录下的main.php,不要在目录中!不要在目录中!不要在目录中!5.输入命令行:phpexecl;//可以输入任何前缀都可以,不要在命令行输入前缀(括号中的路径)6.代码完成后,会生成phpstorm.conf文件这样就可以通过phpstorm导入了。

看视频,读书是为了去理解,

我觉得知乎不太适合提问,更适合分享,目前的我走过了想去知乎学习或者去百度搜索相关问题的整个过程,这是我接触到知乎的第一步,现在我对知乎产生了依赖,

看视频,看php教程,

看视频,看电子书,百度php贴吧或者相关论坛(博客,社区)。

手机备忘录做笔记啊。写下遇到的问题的解决办法。

理论好,学起来容易很多,真正掌握php有点难,必须刷题,然后多敲。

既然已经学会php了,应该了解,网页的加载原理了吧,w3c在这方面有太多的资料了,简单说就是让页面加载一些数据或者服务,等数据读取完了把这些加载后的数据,转换成我们需要的动态的东西。数据编码。等等等等。不管你后端的处理多牛逼,服务器的处理多牛逼,php很难实现对所有的后端数据展示逻辑的灵活处理。

用phpmyadmin插件安装web.url抓取的具体步骤:抓取

网站优化 • 优采云 发表了文章 • 0 个评论 • 123 次浏览 • 2022-06-16 12:01

php抓取网页域名:

1、用phpmyadmin插件安装

2、在phpmyadmin中创建账户名admin,绑定域名,然后登录域名,查看工作目录。

下面讲解phpmyadmin抓取的具体步骤:

1、用username命令设置用户名setusername@'%'web.name"solarfield"

2、用admin命令修改用户密码setadmin@'%'adminsetpassword@'%'web.name"solarfield"

3、修改首次登录的邮箱账号和密码set@'%'@'%'@'%'web.email"solarfield"

5、修改登录后次次登录的域名set@'%'@'%'@'%'web.url"solarfield"web.name"solarfield"

用c/c++重新实现下最简单的curl命令行抓取的功能,

现在phpstorm中一步一步填下去试下吧

仔细阅读后面的代码就会发现,

呃,

有点儿类似:看renfifo

可以试试在web服务器中执行phphttpformaction

讲讲自己的方案:通过参数获取,就是你服务器出来那一步。

用webm, 查看全部

用phpmyadmin插件安装web.url抓取的具体步骤:抓取

php抓取网页域名:

1、用phpmyadmin插件安装

2、在phpmyadmin中创建账户名admin,绑定域名,然后登录域名,查看工作目录。

下面讲解phpmyadmin抓取的具体步骤:

1、用username命令设置用户名setusername@'%'web.name"solarfield"

2、用admin命令修改用户密码setadmin@'%'adminsetpassword@'%'web.name"solarfield"

3、修改首次登录的邮箱账号和密码set@'%'@'%'@'%'web.email"solarfield"

5、修改登录后次次登录的域名set@'%'@'%'@'%'web.url"solarfield"web.name"solarfield"

用c/c++重新实现下最简单的curl命令行抓取的功能,

现在phpstorm中一步一步填下去试下吧

仔细阅读后面的代码就会发现,

呃,

有点儿类似:看renfifo

可以试试在web服务器中执行phphttpformaction

讲讲自己的方案:通过参数获取,就是你服务器出来那一步。

用webm,

php抓取网页域名url通过定制ga测试网页质量比较高

网站优化 • 优采云 发表了文章 • 0 个评论 • 108 次浏览 • 2022-06-05 03:01

php抓取网页域名url通过定制ga测试网页质量.将谷歌等浏览器插件,安装到php里面,通过发送ga到服务器检测哪个页面质量比较高,最好通过定制安装脚本来进行执行,最后结果通过服务器中间人注入js脚本php抓取页面数据并且进行数据处理

先看php网站权重是多少:看页面的权重是通过什么方式计算出来的,可以查看自己网站的历史数据,看权重的计算方式是怎么样的,还有自己的网站每月换ip次数、注册用户次数、pv次数等,

主要是通过页面ip访问的数量和pv访问的数量来预估的吧

看页面权重?什么页面权重?你就把他写在脚本里面去调试就好了,通过数量和pv做一些大概的比对

从这个页面开始

seo分析应该是最基础的seo吧,权重的反向问题就不知道怎么回答了。

1是权重2如果你能搜到我

1是pv2请抓取我的页面并查看数据

//楼主可以试试ga/tag=“ga”或者说点击/trait=click/trait=action/trait=location/trait=recipient/s=1/

如果你明确知道一个url访问了多少次,就能大概算出一个页面的总权重,简单的说是页面的metadescription就好。但是如果你记录了这个页面的所有信息,比如首页是做什么的,这个页面是什么链接搭建的,每页跳转多少次,大概一页就有多少次点击,这样一个页面不管是url还是pv其实都是变化的,就好像一个新建的网站和在线的网站一样。

这个时候,url=/android/?android=1,pv不过1,等等。ps:虽然没见过这么算。 查看全部

php抓取网页域名url通过定制ga测试网页质量比较高

php抓取网页域名url通过定制ga测试网页质量.将谷歌等浏览器插件,安装到php里面,通过发送ga到服务器检测哪个页面质量比较高,最好通过定制安装脚本来进行执行,最后结果通过服务器中间人注入js脚本php抓取页面数据并且进行数据处理

先看php网站权重是多少:看页面的权重是通过什么方式计算出来的,可以查看自己网站的历史数据,看权重的计算方式是怎么样的,还有自己的网站每月换ip次数、注册用户次数、pv次数等,

主要是通过页面ip访问的数量和pv访问的数量来预估的吧

看页面权重?什么页面权重?你就把他写在脚本里面去调试就好了,通过数量和pv做一些大概的比对

从这个页面开始

seo分析应该是最基础的seo吧,权重的反向问题就不知道怎么回答了。

1是权重2如果你能搜到我

1是pv2请抓取我的页面并查看数据

//楼主可以试试ga/tag=“ga”或者说点击/trait=click/trait=action/trait=location/trait=recipient/s=1/

如果你明确知道一个url访问了多少次,就能大概算出一个页面的总权重,简单的说是页面的metadescription就好。但是如果你记录了这个页面的所有信息,比如首页是做什么的,这个页面是什么链接搭建的,每页跳转多少次,大概一页就有多少次点击,这样一个页面不管是url还是pv其实都是变化的,就好像一个新建的网站和在线的网站一样。

这个时候,url=/android/?android=1,pv不过1,等等。ps:虽然没见过这么算。

德语2101班级网站镜像部署上线啦!

网站优化 • 优采云 发表了文章 • 0 个评论 • 99 次浏览 • 2022-05-13 14:39

为更好促进外语学习需要,德语2101班已于近日部署完成了部分网站镜像,供各位同学学习与参考。

- 01 -

使用指南

镜像网站可以在上方的导航栏内Mirror栏直达,也可以直接输入/mirror/mirror.html直接进入(手机端推荐此方法),在本公众号内还可以通过阅读原文链接访问。

目前根据我班实际需要部署了中文、英语、德语三种语言的百科内容。本镜像网站的优点在于:无需任何配置,直接使用普通浏览器连接,且访问速度远远快于普通的全局代理模式。用户仅需点击蓝色链接,即可实现对于以上网站的访问。

- 02 -

注意事项(重要!!!)

在使用镜像网站前,您必须充分阅读以下注意事项,并充分理解并声明愿意遵守:

Google镜像仅能访问Google搜索和Google图片,其余Google旗下服务如YouTube、Gmail、Google Drive等暂不支持;

支持终端(Supported Terminal)中显示PC, Portable的,表明其适配了电脑及移动端,手机、电脑浏览器均可直接访问;如仅有PC端,在手机端访问时,可以将手机浏览器的UI(一般在选项或者设置中)调成“电脑模式”或者”桌面端“即可访问;

本镜像网站仅限校内使用,请勿将本页面任何内容、域名、IP地址在任何公网上进行传播!

Google镜像使用单独服务器,三个Wikipedia镜像共用一个服务器,每个服务器瞬时带宽为2TB,为了服务器正常运行,不建议同时上线人数大于25;

服务器已经开启监视器功能,请勿使用本网站从事瞬时、大容量下载,或者爬虫、反向代理等行为,对于明显带宽异常的IP我们会将整个IP段进行封禁;

后期我们将编写使用及维护手册,在2022年5月31日前为试运行阶段,试运行期间不保证服务器的稳定性,可能遭遇停机、重置或者IP更改等问题;

本网站不能抓取您在镜像中输入的任何内容,仅承担中继功能,但同时您也需要注意您是否愿意将您的数据共享给Google LLC,Wikimedia org;

多个域名可能共用同一个IP,因此请不要使用IP地址访问;

- 03 -

我想短暂使用其他受限制网站

您可以通过私信的方式私信网站运营者,并注明使用时间及用途。我们将对服务器进行配置,并允许特定IP在一段时间内的访问。

本服务使用nginx + PHP,cURL,Apache,Node.js在Linux CentOS 7环境下编译完成,部分网页支持Let's Encrypt SSL证书配置,支持PHP 7.x,CentOS7.x 8.x编译环境 查看全部

德语2101班级网站镜像部署上线啦!

为更好促进外语学习需要,德语2101班已于近日部署完成了部分网站镜像,供各位同学学习与参考。

- 01 -

使用指南

镜像网站可以在上方的导航栏内Mirror栏直达,也可以直接输入/mirror/mirror.html直接进入(手机端推荐此方法),在本公众号内还可以通过阅读原文链接访问。

目前根据我班实际需要部署了中文、英语、德语三种语言的百科内容。本镜像网站的优点在于:无需任何配置,直接使用普通浏览器连接,且访问速度远远快于普通的全局代理模式。用户仅需点击蓝色链接,即可实现对于以上网站的访问。

- 02 -

注意事项(重要!!!)

在使用镜像网站前,您必须充分阅读以下注意事项,并充分理解并声明愿意遵守:

Google镜像仅能访问Google搜索和Google图片,其余Google旗下服务如YouTube、Gmail、Google Drive等暂不支持;

支持终端(Supported Terminal)中显示PC, Portable的,表明其适配了电脑及移动端,手机、电脑浏览器均可直接访问;如仅有PC端,在手机端访问时,可以将手机浏览器的UI(一般在选项或者设置中)调成“电脑模式”或者”桌面端“即可访问;

本镜像网站仅限校内使用,请勿将本页面任何内容、域名、IP地址在任何公网上进行传播!

Google镜像使用单独服务器,三个Wikipedia镜像共用一个服务器,每个服务器瞬时带宽为2TB,为了服务器正常运行,不建议同时上线人数大于25;

服务器已经开启监视器功能,请勿使用本网站从事瞬时、大容量下载,或者爬虫、反向代理等行为,对于明显带宽异常的IP我们会将整个IP段进行封禁;

后期我们将编写使用及维护手册,在2022年5月31日前为试运行阶段,试运行期间不保证服务器的稳定性,可能遭遇停机、重置或者IP更改等问题;

本网站不能抓取您在镜像中输入的任何内容,仅承担中继功能,但同时您也需要注意您是否愿意将您的数据共享给Google LLC,Wikimedia org;

多个域名可能共用同一个IP,因此请不要使用IP地址访问;

- 03 -

我想短暂使用其他受限制网站

您可以通过私信的方式私信网站运营者,并注明使用时间及用途。我们将对服务器进行配置,并允许特定IP在一段时间内的访问。

本服务使用nginx + PHP,cURL,Apache,Node.js在Linux CentOS 7环境下编译完成,部分网页支持Let's Encrypt SSL证书配置,支持PHP 7.x,CentOS7.x 8.x编译环境

php抓取网页域名 轻松玩转SEO,看这篇就够了

网站优化 • 优采云 发表了文章 • 0 个评论 • 113 次浏览 • 2022-05-09 07:37

欢迎投稿到早读课,投稿邮箱:

最近在看SEO方面的知识,很是有趣,能学些新东西的感觉总是好的,随着经历增多心境较之前也少了些浮躁,当下的年纪也正是钻研些好玩事物的大好时光,在这里给大家推荐两本SEO的基础入门书籍,《百度SEO一本通》 《7天精通SEO》希望借此文和志同道合者共同进步!

虽然现在最火的SEO书籍是Zac出的那本《SEO实战密码》,豆瓣评分也不错,但实际读来逻辑比较散乱,信息量太大,有点像历史博客文章的堆积,对于刚接触SEO的人来说其实并不适合,个人建议可以先从入门的书籍开始看,形成自己的理解体系,然后再用自己建立起来的这套体系去做加深阅读,这也是我常用的方法,实际说来我看书的量并不多,更偏向看适合自己这个阶段的,去到书中参悟。

首先,让我们先来看看这两本书的逻辑体系,带着方向去阅读

《7天精通SEO》.png

这书本重点看站内篇、站外篇、策略篇部分,这三个部分主要讲做优化的实际方法论,基础篇就是了解大致常识,可以快速浏览,可以和案例篇专题篇组合来看。

《百度SEO一本通》.png

这本书主要看关键词、链接优化技巧,理解和了解网络技术和百度的竞价推广、网盟推广。

接下来,梳理下SEO的基本常识(不完全的部分会在后续补充)

1. SEO定义:

Search Engine Optimization(全称)也即搜索引擎优化,就是从搜索引擎上获得流量的技术。搜索引擎的主要工作包括:通过了解搜索引擎的工作原理掌握如何在网页流中爬取网页、如何进行索引以及如何确定某一关键词排名位置从而对网页内容进行科学的优化,使其符合用户浏览习惯的同时提高排名与网站访问量,最终获得商业化能力的技术。

2. 搜索引擎工作原理:

主要有三段工作流程:爬行抓取、预处理、服务输出

2.1 爬行抓取

主要功能是对网页进行抓取,目前有三种爬行抓取方法

2.1.1 常见蜘蛛

搜索引擎蜘蛛是搜索引擎的一个自动程序,作用是访问互联网上的网页、图片、视频等内容,建立索引库,一般用法为spider+URL这里的URL是搜索引擎的痕迹,可以通过查看服务器里的日志里是否有该URL,同时还能查看一些列属性。

2.1.2 爬行策略

2.1.3 预处理

也即对抓取回来的数据进行一个索引工作,其中包括多个流程,在后台提前完成。

2.1.3.1 关键词提取

将HTML、JS、CSS等标签&程序去除,提取用于排名的有效文字。

2.1.3.2去除停用词

即反复出现的无用词,如:“得、的、地、啊、阿、再”等

2.1.3.3分词技术

是中文搜索引擎特有的技术支持,中文不同于英文单词与单词之间用空格分隔,因此搜索引擎必须把整个句子切割成小单元词,分词的方法有两种

2.1.3.4消除噪声

消除网页上各种广告文字、图片、登录框、版权信息等对搜索引擎无用的东西。

2.1.3.5分析网页建立倒排文件