php抓取开奖网页内容

php抓取开奖网页内容(php抓取开奖网页内容属于php逆向处理,最简单的方法)

网站优化 • 优采云 发表了文章 • 0 个评论 • 91 次浏览 • 2021-10-07 04:02

php抓取开奖网页内容属于php逆向处理,最简单的方法是php爬虫再次封装一层函数,找到正确的密码,正则匹配,发送到服务器,最终还是用php去获取数据,最好做一层反向代理,

可以考虑从人人抓取你校验过的校验码对应的电话号码数据,再通过php+requests把数据抓出来贴出来。

大牛一枚,

爬数据是有技巧的,如果是数据直接存储在本地,最好用一些php框架,例如爬虫框架,或者python的httplib库,会比较方便,之前写过一个爬虫小项目,分享给你,

要么用php反向代理抓,要么直接laravel之类,但是一般没这个需求。

php反向代理抓

phpproxy

网页一般是http协议加socket,proxy也好restfulapi也好。你要抓取本地网页前两者很合适,proxy抓不了就弄个透明代理,或者有人推荐的meb/fooying8,直接抓上层网页。

pc端,可以通过ssh公网ip,

可以使用爬虫框架或者网站抓取

爬虫。hashtag,爬虫可以抓取网页内容。

用nginx反向代理啊。

代理一下

你可以用selenium+python抓取哦。国内的有百度和腾讯,爬虫代理有一家叫云象,建议百度尝试一下。除此之外这里还有大量爬虫相关文章哦:大量爬虫——python爬虫开发者学习必读(上);大量爬虫——python爬虫开发者学习必读(下);欢迎持续关注。 查看全部

php抓取开奖网页内容(php抓取开奖网页内容属于php逆向处理,最简单的方法)

php抓取开奖网页内容属于php逆向处理,最简单的方法是php爬虫再次封装一层函数,找到正确的密码,正则匹配,发送到服务器,最终还是用php去获取数据,最好做一层反向代理,

可以考虑从人人抓取你校验过的校验码对应的电话号码数据,再通过php+requests把数据抓出来贴出来。

大牛一枚,

爬数据是有技巧的,如果是数据直接存储在本地,最好用一些php框架,例如爬虫框架,或者python的httplib库,会比较方便,之前写过一个爬虫小项目,分享给你,

要么用php反向代理抓,要么直接laravel之类,但是一般没这个需求。

php反向代理抓

phpproxy

网页一般是http协议加socket,proxy也好restfulapi也好。你要抓取本地网页前两者很合适,proxy抓不了就弄个透明代理,或者有人推荐的meb/fooying8,直接抓上层网页。

pc端,可以通过ssh公网ip,

可以使用爬虫框架或者网站抓取

爬虫。hashtag,爬虫可以抓取网页内容。

用nginx反向代理啊。

代理一下

你可以用selenium+python抓取哦。国内的有百度和腾讯,爬虫代理有一家叫云象,建议百度尝试一下。除此之外这里还有大量爬虫相关文章哦:大量爬虫——python爬虫开发者学习必读(上);大量爬虫——python爬虫开发者学习必读(下);欢迎持续关注。

php抓取开奖网页内容(懒惰匹配,也就是能匹配得越少喔(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 175 次浏览 • 2021-10-04 11:09

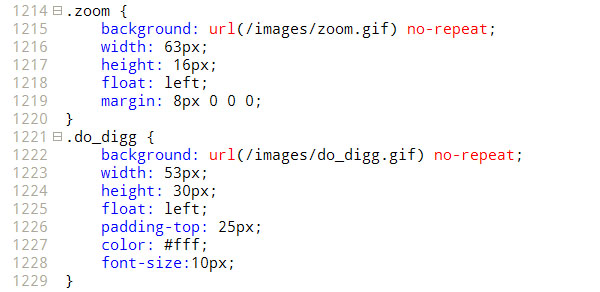

//这里用正则表达式取出来,不要忘记在后端加一个斜杠。

//.*? 是懒匹配,也就是你能匹配的越少,能匹配的内容就越少,这样你就不会赶超了。

$host = $host[1];

2. 构建图片存储文件夹:

> 小谢这里用is_dir来判断文件夹是否存在。如果存在,则无需第二次创建。

> 哈哈,对了,is_file函数可以判断这个文件是正常文件还是存在。

> 但是file_exists() 好一点,因为我看到上面有人讨论过。

if (!is_dir('img')) {mkdir('img');}

> 3. 使用正则表达式提取图片的相对地址:

$regex ='/url('{0,1}"{0,1}(.*?)'{0,1}"{0,1})/';

//这里我们使用正则表达式来匹配图片地址,需要考虑三种情况,分别是url(1.gif) url('1.gif') url("1. gif”)。

//这三种写法都可以,所以我们用上面的正则把里面的1.gif取出来。

//'{0,1} 表示单引号可能出现 1 次或 0 次,“表示双引号可能出现 1 次或 0 次。

//中间一定要用懒匹配,否则会1.gif"而不是1.gif鸟,O(∩_∩)P。

preg_match_all($regex,$data,$result);

> 4. 处理这些图片:

> 首先使用循环处理正则规则提取的第一个分支的内容数组。

> 呃,这里的第一个分支是指正则表达式中的第一个括号,呵呵,以此类推。

foreach ($result[1] as $val) {}

> 然后我们用正则表达式来判断,因为我们还需要考虑/upload/201109/203807.gif。

> 这使用完整路径而不是像其他人一样的 /img/1.gif 或 img/1.gif。

> 所以分开判断,再判断这两个,看是/img/1.gif还是img/1.gif。

复制代码代码如下:

if (preg_match('/^http.*/',$val)) {$target = $val;}

else if (preg_match('/^/.*/',$val)) {$target=$host.$val;}

否则 {$target=$url.$val;}

回声$目标。”

rn";

> 最后取出文件名,即/img/1.gif中的1.gif,保存文件。

复制代码代码如下:

preg_match('/.*/(.*.D+)$/',$val,$name);

> 然后我们就可以开始下载了,这里是一个强大的复制功能用法。

复制代码代码如下:

if (!is_file('./img/'.$name[1])) {

$imgc = file_get_contents($target);

$handle = fopen('./img/'.$name[1],'w+');

fwrite($handle,$imgc);

fclose($handle);

}

> 上面一个是我们的老方法,嘎嘎,很麻烦。有一次,小邪突然发现了复制的力量。

> 复制也可以下载,这样就可以方便的用下面的代码来处理了,上面的就可以退鸟了。

复制代码代码如下:

if (!is_file('./img/'.$name[1])) {

copy($target,'./img/'.$name[1]);

}

> 5. 完整源码:

> 使用时只需填写$url,然后将所有CSS内容保存在abc.css中。

复制代码代码如下:

现在玩微博的人越来越多,微博上的第三方应用开发也越来越多。偶然接触到新浪微博API开发。新浪微博API开发资源比较大。新浪微博为开发者提供了一个平台。网站为: 收录新浪微博开发的综合信息,包括开发者的使用和介绍、各种语言的API功能介绍文档、SDK等资料。.

在开发和学习的过程中,感觉虽然不是太难,但还是有一些问题需要大家注意。今天在开发学习的过程中,简单的用PHP开发了新浪微博API。内容组织和解释,

新浪微博API开发前的准备

首先到新浪微博开放平台下载基于PHP的SDK开发包。下载地址为:

下载完成后放到自己的开发环境中解压。演示程序也包括在内。我们可以参考它的示例程序进行编写。

新浪微博API开发最重要的用户授权流程

事实上,开发过程中的很多问题都集中在用户授权阶段。我开发的第三方应用使用的是OAuth授权。OAuth授权流程在新浪微博开放平台上有非常清晰完整的介绍。我们你可以看看。这里我将从示例开发的角度进行介绍和说明。

1.首先获取未授权的Request Token

复制代码代码如下:

$o = new WeiboOAuth( WB_AKEY, WB_SKEY );

$keys = $o->getRequestToken();

//echo($keys['oauth_token'].':'.$keys['oauth_token_secret']);

我们需要在新浪微博开放平台注册一个账号,或者直接用我们的新浪微博账号登录,进入我的应用,然后按照提示创建我们自己的第三方应用。创建完成后,我们可以得到两个授权App Key和App Secret值,这两个值是我们应用开发的关键。

获取到授权值后,我们可以通过上面的代码来获取未授权的Request Token值,该值会保存在$key数组变量中。

2. 然后请求用户授权token

复制代码代码如下:

$_SESSION['keys'] = $keys;

aurl = $o->getAuthorizeURL( $keys['oauth_token'] ,false,'');

获取到未授权Request Token值后,我们就可以使用上面的代码准备去新浪微博授权页面进行授权了。$aurl 是授权链接页面。得到$aurl后,我们可以使用header()直接跳转到它。授权页面,然后用户输入新浪微博账号和密码进行授权。授权完成后会自动跳转回你最后一个参数设置的回调页面:这个链接可以设置为上一个页面,这样授权完成后会显示 再次自动跳转回来。

需要说明的是,需要设置session key的值,下面获取的授权Access Token中需要该值。很多朋友可能会参考开放平台上的说明进行授权,但是发现总是报错。这通常是问题所在。您尚未设置会话的键值。当然,下面的Access Token的值是无法获取的。必须记住这一点。

3.最后是用户授权的Access Token

复制代码代码如下:

$o = new WeiboOAuth( WB_AKEY,

WB_SKEY,

$_SESSION['keys']['oauth_token'],

$_SESSION['keys']['oauth_token_secret'] );

$last_key = $o->getAccessToken( $_REQUEST['oauth_verifier']);

回声($last_key['oauth_token']);

以上代码最终获得了用户授权的Access Token。有两个值,它们存储在 $last_key 数组变量中。我们也可以看到最后两个参数是我们之前设置的session值。至此,基本完成。这是一个完整的新浪微博用户授权流程。

授权完成后工作

授权完成后,我们就可以开始调用新浪微博提供的各种API函数接口进行实际应用开发了。这里我简单介绍一下获取最新微博记录的界面。其他类似。

获取新浪微博最新信息的API接口函数为:public_timeline(),示例代码如下:

复制代码代码如下:

//获取前20条最新更新的公众微博新闻

$c = 新微博客户端( WB_AKEY,

WB_SKEY,

$oauth_token,

$oauth_token_secret );

$msg = $c->public_timeline();

if ($msg === false || $msg === null){

echo "发生错误";

返回假;

}

if (isset($msg['error_code']) && isset($msg['error'])){

echo ('Error_code:'.$msg['error_code'].'; Error:'.$msg['error'] );

返回假;

}

打印_r($msg);

通常我们拿到用户授权的访问令牌值后,我们将它们保存在我们的用户表中,并与我们应用程序中的帐户相对应。之后我们就不用每次调用新浪微博的API接口都去。认证。

上面的代码很简单,实例化WeiboClient对象,然后直接调用接口函数public_timeline获取返回的信息,如果没有报错。通常新浪微博api接口返回的数据格式一般是Json格式或者xml格式,而我们这里是用php开发的,使用Json格式的数据有先天优势,如果返回Json格式的数据,使用php 函数 json_decode() 可以直接转换成 PHP 常用的数组格式。

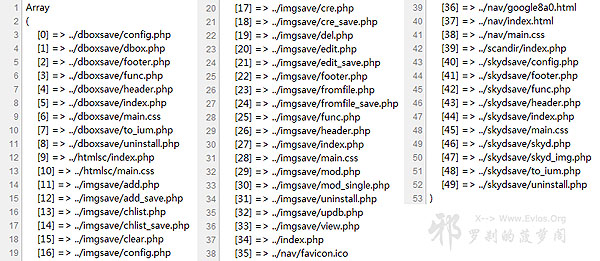

我们要使用的函数是Scandir,用于列出指定路径下的文件和目录,就像Dir一样。

> 有了更强大的Glob()函数,功能就是以数组的形式返回匹配指定模式的文件名或目录。

> 友情提示,不要像小邪一样在电脑前呆太久,否则你会像小邪一样血糖升高。

一. 遍历单级文件夹:

> 扫描单级文件夹的问题是,虽然两个函数的结果不同,但性能差别不大。

> Scandir 函数将提供两行额外的行,它们是“.”。和“..”,但 Glob 没有。

复制代码代码如下:

函数 get_dir_scandir(){

$tree = 数组();

foreach(scandir('./') as $single){

回声 $single。”

rn";

}

}

get_dir_scandir();

函数 get_dir_glob(){

$tree = 数组();

foreach(glob('./*') 作为 $single){

回声 $single。”

rn";

}

}

get_dir_glob();

二. 递归遍历文件树:

> 在递归扫描文件夹树的问题上,Glob函数还是表现得比较好,非常准确。

> Scandir 功能会莫名其妙地扫描../ 处的文件两次,也就是说,如果小谢有两个文件。

> ../b.php 和../a.php,结果会在扫描报告上出现两次,很奇怪。

复制代码代码如下:

//更新于2010.07.25-以下代码无效

$path ='..';

函数 get_filetree_scandir($path){

$tree = 数组();

foreach(scandir($path) 作为 $single){

if(is_dir('../'.$single)){

$tree = array_merge($tree,get_filetree($single));

}

别的{

$tree[] ='../'.$single;

}

}

返回 $tree;

}

print_r(get_filetree_scandir($path));

//更新在2010.07.25-以下是新代码

$path ='./';

函数 get_filetree_scandir($path){

$result = array();

$temp = 数组();

if (!is_dir($path)||!is_readable($path)) 返回空值;//检查目录的有效性

$allfiles = scandir($path); //获取目录下的所有文件和文件夹

foreach ($allfiles as $filename) {//遍历目录下的文件和文件夹

if (in_array($filename,array('.','..'))) 继续;//忽略。和..

$fullname = $path.'/'.$filename; //获取完整文件路径

if (is_dir($fullname)) {//如果是目录,继续递归

$result[$filename] = get_filetree_scandir($fullname); //递归开始

}

别的 {

$temp[] = $文件名;//如果是文件,则存入数组

}

}

foreach ($temp as $tmp) {//将临时数组的内容存入保存结果的数组

$result[] = $tmp; //这允许文件夹在前面,文件在后面

}

返回 $result;

}

print_r(get_filetree_scandir($path));

> Glob 函数扫描非常准确,会自动按照字母顺序排列,这似乎是最好的解决方案。

复制代码代码如下:

$path ='..';

函数 get_filetree($path){

$tree = 数组();

foreach(glob($path.'/*') as $single){

if(is_dir($single)){

$tree = array_merge($tree,get_filetree($single));

}

别的{

$tree[] = $single;

}

}

返回 $tree;

}

print_r(get_filetree($path));

【PHP遍历文件夹和子目录的函数代码】相关文章:

★ 使用 PHP 4.2 编写安全脚本

★ PHP 中如何获取文件行数

★ 完整版多文件上传系统

★ php中使用curl打开https网站

★ PHP中使用的JS打印功能

★ 用PHP创建PDF中文文档

★ 使用PHP调用数据库的存储过程

★ 使用PHP上传文件

★ 一段PHP加解密代码

★ 多文件上传示例 查看全部

php抓取开奖网页内容(懒惰匹配,也就是能匹配得越少喔(组图))

//这里用正则表达式取出来,不要忘记在后端加一个斜杠。

//.*? 是懒匹配,也就是你能匹配的越少,能匹配的内容就越少,这样你就不会赶超了。

$host = $host[1];

2. 构建图片存储文件夹:

> 小谢这里用is_dir来判断文件夹是否存在。如果存在,则无需第二次创建。

> 哈哈,对了,is_file函数可以判断这个文件是正常文件还是存在。

> 但是file_exists() 好一点,因为我看到上面有人讨论过。

if (!is_dir('img')) {mkdir('img');}

> 3. 使用正则表达式提取图片的相对地址:

$regex ='/url('{0,1}"{0,1}(.*?)'{0,1}"{0,1})/';

//这里我们使用正则表达式来匹配图片地址,需要考虑三种情况,分别是url(1.gif) url('1.gif') url("1. gif”)。

//这三种写法都可以,所以我们用上面的正则把里面的1.gif取出来。

//'{0,1} 表示单引号可能出现 1 次或 0 次,“表示双引号可能出现 1 次或 0 次。

//中间一定要用懒匹配,否则会1.gif"而不是1.gif鸟,O(∩_∩)P。

preg_match_all($regex,$data,$result);

> 4. 处理这些图片:

> 首先使用循环处理正则规则提取的第一个分支的内容数组。

> 呃,这里的第一个分支是指正则表达式中的第一个括号,呵呵,以此类推。

foreach ($result[1] as $val) {}

> 然后我们用正则表达式来判断,因为我们还需要考虑/upload/201109/203807.gif。

> 这使用完整路径而不是像其他人一样的 /img/1.gif 或 img/1.gif。

> 所以分开判断,再判断这两个,看是/img/1.gif还是img/1.gif。

复制代码代码如下:

if (preg_match('/^http.*/',$val)) {$target = $val;}

else if (preg_match('/^/.*/',$val)) {$target=$host.$val;}

否则 {$target=$url.$val;}

回声$目标。”

rn";

> 最后取出文件名,即/img/1.gif中的1.gif,保存文件。

复制代码代码如下:

preg_match('/.*/(.*.D+)$/',$val,$name);

> 然后我们就可以开始下载了,这里是一个强大的复制功能用法。

复制代码代码如下:

if (!is_file('./img/'.$name[1])) {

$imgc = file_get_contents($target);

$handle = fopen('./img/'.$name[1],'w+');

fwrite($handle,$imgc);

fclose($handle);

}

> 上面一个是我们的老方法,嘎嘎,很麻烦。有一次,小邪突然发现了复制的力量。

> 复制也可以下载,这样就可以方便的用下面的代码来处理了,上面的就可以退鸟了。

复制代码代码如下:

if (!is_file('./img/'.$name[1])) {

copy($target,'./img/'.$name[1]);

}

> 5. 完整源码:

> 使用时只需填写$url,然后将所有CSS内容保存在abc.css中。

复制代码代码如下:

现在玩微博的人越来越多,微博上的第三方应用开发也越来越多。偶然接触到新浪微博API开发。新浪微博API开发资源比较大。新浪微博为开发者提供了一个平台。网站为: 收录新浪微博开发的综合信息,包括开发者的使用和介绍、各种语言的API功能介绍文档、SDK等资料。.

在开发和学习的过程中,感觉虽然不是太难,但还是有一些问题需要大家注意。今天在开发学习的过程中,简单的用PHP开发了新浪微博API。内容组织和解释,

新浪微博API开发前的准备

首先到新浪微博开放平台下载基于PHP的SDK开发包。下载地址为:

下载完成后放到自己的开发环境中解压。演示程序也包括在内。我们可以参考它的示例程序进行编写。

新浪微博API开发最重要的用户授权流程

事实上,开发过程中的很多问题都集中在用户授权阶段。我开发的第三方应用使用的是OAuth授权。OAuth授权流程在新浪微博开放平台上有非常清晰完整的介绍。我们你可以看看。这里我将从示例开发的角度进行介绍和说明。

1.首先获取未授权的Request Token

复制代码代码如下:

$o = new WeiboOAuth( WB_AKEY, WB_SKEY );

$keys = $o->getRequestToken();

//echo($keys['oauth_token'].':'.$keys['oauth_token_secret']);

我们需要在新浪微博开放平台注册一个账号,或者直接用我们的新浪微博账号登录,进入我的应用,然后按照提示创建我们自己的第三方应用。创建完成后,我们可以得到两个授权App Key和App Secret值,这两个值是我们应用开发的关键。

获取到授权值后,我们可以通过上面的代码来获取未授权的Request Token值,该值会保存在$key数组变量中。

2. 然后请求用户授权token

复制代码代码如下:

$_SESSION['keys'] = $keys;

aurl = $o->getAuthorizeURL( $keys['oauth_token'] ,false,'');

获取到未授权Request Token值后,我们就可以使用上面的代码准备去新浪微博授权页面进行授权了。$aurl 是授权链接页面。得到$aurl后,我们可以使用header()直接跳转到它。授权页面,然后用户输入新浪微博账号和密码进行授权。授权完成后会自动跳转回你最后一个参数设置的回调页面:这个链接可以设置为上一个页面,这样授权完成后会显示 再次自动跳转回来。

需要说明的是,需要设置session key的值,下面获取的授权Access Token中需要该值。很多朋友可能会参考开放平台上的说明进行授权,但是发现总是报错。这通常是问题所在。您尚未设置会话的键值。当然,下面的Access Token的值是无法获取的。必须记住这一点。

3.最后是用户授权的Access Token

复制代码代码如下:

$o = new WeiboOAuth( WB_AKEY,

WB_SKEY,

$_SESSION['keys']['oauth_token'],

$_SESSION['keys']['oauth_token_secret'] );

$last_key = $o->getAccessToken( $_REQUEST['oauth_verifier']);

回声($last_key['oauth_token']);

以上代码最终获得了用户授权的Access Token。有两个值,它们存储在 $last_key 数组变量中。我们也可以看到最后两个参数是我们之前设置的session值。至此,基本完成。这是一个完整的新浪微博用户授权流程。

授权完成后工作

授权完成后,我们就可以开始调用新浪微博提供的各种API函数接口进行实际应用开发了。这里我简单介绍一下获取最新微博记录的界面。其他类似。

获取新浪微博最新信息的API接口函数为:public_timeline(),示例代码如下:

复制代码代码如下:

//获取前20条最新更新的公众微博新闻

$c = 新微博客户端( WB_AKEY,

WB_SKEY,

$oauth_token,

$oauth_token_secret );

$msg = $c->public_timeline();

if ($msg === false || $msg === null){

echo "发生错误";

返回假;

}

if (isset($msg['error_code']) && isset($msg['error'])){

echo ('Error_code:'.$msg['error_code'].'; Error:'.$msg['error'] );

返回假;

}

打印_r($msg);

通常我们拿到用户授权的访问令牌值后,我们将它们保存在我们的用户表中,并与我们应用程序中的帐户相对应。之后我们就不用每次调用新浪微博的API接口都去。认证。

上面的代码很简单,实例化WeiboClient对象,然后直接调用接口函数public_timeline获取返回的信息,如果没有报错。通常新浪微博api接口返回的数据格式一般是Json格式或者xml格式,而我们这里是用php开发的,使用Json格式的数据有先天优势,如果返回Json格式的数据,使用php 函数 json_decode() 可以直接转换成 PHP 常用的数组格式。

我们要使用的函数是Scandir,用于列出指定路径下的文件和目录,就像Dir一样。

> 有了更强大的Glob()函数,功能就是以数组的形式返回匹配指定模式的文件名或目录。

> 友情提示,不要像小邪一样在电脑前呆太久,否则你会像小邪一样血糖升高。

一. 遍历单级文件夹:

> 扫描单级文件夹的问题是,虽然两个函数的结果不同,但性能差别不大。

> Scandir 函数将提供两行额外的行,它们是“.”。和“..”,但 Glob 没有。

复制代码代码如下:

函数 get_dir_scandir(){

$tree = 数组();

foreach(scandir('./') as $single){

回声 $single。”

rn";

}

}

get_dir_scandir();

函数 get_dir_glob(){

$tree = 数组();

foreach(glob('./*') 作为 $single){

回声 $single。”

rn";

}

}

get_dir_glob();

二. 递归遍历文件树:

> 在递归扫描文件夹树的问题上,Glob函数还是表现得比较好,非常准确。

> Scandir 功能会莫名其妙地扫描../ 处的文件两次,也就是说,如果小谢有两个文件。

> ../b.php 和../a.php,结果会在扫描报告上出现两次,很奇怪。

复制代码代码如下:

//更新于2010.07.25-以下代码无效

$path ='..';

函数 get_filetree_scandir($path){

$tree = 数组();

foreach(scandir($path) 作为 $single){

if(is_dir('../'.$single)){

$tree = array_merge($tree,get_filetree($single));

}

别的{

$tree[] ='../'.$single;

}

}

返回 $tree;

}

print_r(get_filetree_scandir($path));

//更新在2010.07.25-以下是新代码

$path ='./';

函数 get_filetree_scandir($path){

$result = array();

$temp = 数组();

if (!is_dir($path)||!is_readable($path)) 返回空值;//检查目录的有效性

$allfiles = scandir($path); //获取目录下的所有文件和文件夹

foreach ($allfiles as $filename) {//遍历目录下的文件和文件夹

if (in_array($filename,array('.','..'))) 继续;//忽略。和..

$fullname = $path.'/'.$filename; //获取完整文件路径

if (is_dir($fullname)) {//如果是目录,继续递归

$result[$filename] = get_filetree_scandir($fullname); //递归开始

}

别的 {

$temp[] = $文件名;//如果是文件,则存入数组

}

}

foreach ($temp as $tmp) {//将临时数组的内容存入保存结果的数组

$result[] = $tmp; //这允许文件夹在前面,文件在后面

}

返回 $result;

}

print_r(get_filetree_scandir($path));

> Glob 函数扫描非常准确,会自动按照字母顺序排列,这似乎是最好的解决方案。

复制代码代码如下:

$path ='..';

函数 get_filetree($path){

$tree = 数组();

foreach(glob($path.'/*') as $single){

if(is_dir($single)){

$tree = array_merge($tree,get_filetree($single));

}

别的{

$tree[] = $single;

}

}

返回 $tree;

}

print_r(get_filetree($path));

【PHP遍历文件夹和子目录的函数代码】相关文章:

★ 使用 PHP 4.2 编写安全脚本

★ PHP 中如何获取文件行数

★ 完整版多文件上传系统

★ php中使用curl打开https网站

★ PHP中使用的JS打印功能

★ 用PHP创建PDF中文文档

★ 使用PHP调用数据库的存储过程

★ 使用PHP上传文件

★ 一段PHP加解密代码

★ 多文件上传示例

php抓取开奖网页内容(网站收录、快速排名、发包快排代理OEM:优采云采集网站php源码)

网站优化 • 优采云 发表了文章 • 0 个评论 • 96 次浏览 • 2021-10-04 04:01

网站收录,快速排名,快速调度代理OEM:【】

优采云采集网站php源码:有没有人参加过SEM和seo培训,价格多少?

1、一般来说,最低要求的外链专家最低分应该是20005000一个月。技能好的话,最低工资5000。这里有个问题。很多人对SEO不是很了解,但是他们在做SEO工作。如果拿不到高薪,就觉得做SEO很辛苦,没有前途。真正的大师为自己做。

优采云采集网站php源码,著名网站

2、就目前对SEO的理解,很多互联网公司还是会发链接,更新。所以如果你说去公司学习,我建议你忘记它。首先,公司不一定要做。其次,老板招聘你是为了让你为他创造利润。这不是你学习的。当然可以学,但前提是绝对的。不影响工作。

3、如果你真的有兴趣,认真学习,专心学习,不要想着去上班,如果你学得好,找到工作,公司就急着问你。

优采云采集网站php源码:如何解决网站的收录问题

网站收录这个问题一直困扰着我们,因为如果百度不收录,我们所有的工作都会白费,所以网站收录很重要那么怎样才能提高网站收录的率呢?做好以下三点,网站绝对可以快速收录。

第一:尽量增加蜘蛛访问频率网站;

第二:网站建立良好的站点结构;

第三:让蜘蛛知道我们的网站值对用户有用。

一、 增加蜘蛛访问频率 网站

网站 蜘蛛访问我们的次数越多,网站 成为 收录 的可能性就越大。我们通常的操作方式是站内站外:

站内:保持固定频率,固定更新网站的内容,但必须保证内容质量,否则适得其反。

站外:在高权重网站中,投稿增加网站的权重,吸引蜘蛛访问网站。

二、 建立良好的站点结构

仅仅吸引蜘蛛是不够的。有必要构建网站结构,让蜘蛛在网站中畅通无阻地爬行。我们可以使用面包屑导航、网站地图等来保证蜘蛛顺利抓取网站上的所有网页。

注意:不要使用 js、flash 和 iframe 框架,因为这些蜘蛛是无法识别的。

通常站点的内部结构可以是树状结构,但是小的网站最好扁平化:

①首页链接到所有频道首页

②所有频道首页都连接到其他频道首页

③频道首页总是回到网站的首页

④频道首页还链接到自己频道的内容页

⑤所有内容页面链接到网站首页

⑥所有内容页面都连接到其上级频道的首页

⑦内容页可以连接到同一频道的其他内容页

⑧内容页一般不连接其他频道的内容页

三、 让蜘蛛知道网页的价值和意义

优采云采集网站php源码,著名网站

如果想让搜索引擎对收录网站内容,首先需要证明内容的价值。

①原创度数:写作水平不是很好,可以适当伪原创,然后用原创度数检测工具检查一下。努力做好原创高内容。

②降低网站内部信息内容的重复率。

③网页字数不少于300字。当然,拥有的越多,收录的可能性就越大。

此外,站长还可以利用内页和外链来引导百度抓取内页。这个方法效果很好!

优采云采集网站php源码:想在合肥学习SEO。合肥有谁培训SEO,实力如何?

合肥这边的SEO工资不高,很正常。您可以在进行 SEO 的同时学习美术软件和一些程序。就这样,一年之内,你的知识和掌握的都全面了,然后你我再找工作,肯定5000。我相信你能做到

优采云采集网站php源码,著名网站优采云采集网站php源码:网站how打造360搜索引擎收录5

360收录网站,主要有3个步骤:

1、检查你的网站robotstxt文件是否允许360搜索蜘蛛抓取;爬取后可以直接进行第三步;

2、没有被捕获,请在你的网站代码中的robotstxt文件中添加以下代码:Useragent 360SpiderAllow /

3、登录360综合搜索并提交收录申请。等待批准。

基本流程如上。想要提高被收录的概率,需要做相应的SEO优化工作,完善自己的流程,这样被收录的概率才会高。还可以执行其他操作来增加成为收录的概率:

一是为360搜索制作友情链接,二是联系360搜索的工作人员,并给予一定的排名广告费用,三是优化关键词的内容, 网站等SEO优化工作。

只有彻底优化网站,增加网站本身的流量,收录网站对双方都是有利的。

优采云采集网站php源码,有名的网站优采云采集网站php源码:什么样的网站 易做百度收录

持续更新,坚持原创内容网站。

有一定数量的外链,以及专注于某个行业的网站。

优采云采集网站php源码,著名网站

访问通畅,速度正常网站。 查看全部

php抓取开奖网页内容(网站收录、快速排名、发包快排代理OEM:优采云采集网站php源码)

网站收录,快速排名,快速调度代理OEM:【】

优采云采集网站php源码:有没有人参加过SEM和seo培训,价格多少?

1、一般来说,最低要求的外链专家最低分应该是20005000一个月。技能好的话,最低工资5000。这里有个问题。很多人对SEO不是很了解,但是他们在做SEO工作。如果拿不到高薪,就觉得做SEO很辛苦,没有前途。真正的大师为自己做。

优采云采集网站php源码,著名网站

2、就目前对SEO的理解,很多互联网公司还是会发链接,更新。所以如果你说去公司学习,我建议你忘记它。首先,公司不一定要做。其次,老板招聘你是为了让你为他创造利润。这不是你学习的。当然可以学,但前提是绝对的。不影响工作。

3、如果你真的有兴趣,认真学习,专心学习,不要想着去上班,如果你学得好,找到工作,公司就急着问你。

优采云采集网站php源码:如何解决网站的收录问题

网站收录这个问题一直困扰着我们,因为如果百度不收录,我们所有的工作都会白费,所以网站收录很重要那么怎样才能提高网站收录的率呢?做好以下三点,网站绝对可以快速收录。

第一:尽量增加蜘蛛访问频率网站;

第二:网站建立良好的站点结构;

第三:让蜘蛛知道我们的网站值对用户有用。

一、 增加蜘蛛访问频率 网站

网站 蜘蛛访问我们的次数越多,网站 成为 收录 的可能性就越大。我们通常的操作方式是站内站外:

站内:保持固定频率,固定更新网站的内容,但必须保证内容质量,否则适得其反。

站外:在高权重网站中,投稿增加网站的权重,吸引蜘蛛访问网站。

二、 建立良好的站点结构

仅仅吸引蜘蛛是不够的。有必要构建网站结构,让蜘蛛在网站中畅通无阻地爬行。我们可以使用面包屑导航、网站地图等来保证蜘蛛顺利抓取网站上的所有网页。

注意:不要使用 js、flash 和 iframe 框架,因为这些蜘蛛是无法识别的。

通常站点的内部结构可以是树状结构,但是小的网站最好扁平化:

①首页链接到所有频道首页

②所有频道首页都连接到其他频道首页

③频道首页总是回到网站的首页

④频道首页还链接到自己频道的内容页

⑤所有内容页面链接到网站首页

⑥所有内容页面都连接到其上级频道的首页

⑦内容页可以连接到同一频道的其他内容页

⑧内容页一般不连接其他频道的内容页

三、 让蜘蛛知道网页的价值和意义

优采云采集网站php源码,著名网站

如果想让搜索引擎对收录网站内容,首先需要证明内容的价值。

①原创度数:写作水平不是很好,可以适当伪原创,然后用原创度数检测工具检查一下。努力做好原创高内容。

②降低网站内部信息内容的重复率。

③网页字数不少于300字。当然,拥有的越多,收录的可能性就越大。

此外,站长还可以利用内页和外链来引导百度抓取内页。这个方法效果很好!

优采云采集网站php源码:想在合肥学习SEO。合肥有谁培训SEO,实力如何?

合肥这边的SEO工资不高,很正常。您可以在进行 SEO 的同时学习美术软件和一些程序。就这样,一年之内,你的知识和掌握的都全面了,然后你我再找工作,肯定5000。我相信你能做到

优采云采集网站php源码,著名网站优采云采集网站php源码:网站how打造360搜索引擎收录5

360收录网站,主要有3个步骤:

1、检查你的网站robotstxt文件是否允许360搜索蜘蛛抓取;爬取后可以直接进行第三步;

2、没有被捕获,请在你的网站代码中的robotstxt文件中添加以下代码:Useragent 360SpiderAllow /

3、登录360综合搜索并提交收录申请。等待批准。

基本流程如上。想要提高被收录的概率,需要做相应的SEO优化工作,完善自己的流程,这样被收录的概率才会高。还可以执行其他操作来增加成为收录的概率:

一是为360搜索制作友情链接,二是联系360搜索的工作人员,并给予一定的排名广告费用,三是优化关键词的内容, 网站等SEO优化工作。

只有彻底优化网站,增加网站本身的流量,收录网站对双方都是有利的。

优采云采集网站php源码,有名的网站优采云采集网站php源码:什么样的网站 易做百度收录

持续更新,坚持原创内容网站。

有一定数量的外链,以及专注于某个行业的网站。

优采云采集网站php源码,著名网站

访问通畅,速度正常网站。

php抓取开奖网页内容(网页爬取代码地址:西方人口数据文本编辑程序:headers中添加hosts)

网站优化 • 优采云 发表了文章 • 0 个评论 • 93 次浏览 • 2021-10-01 10:01

php抓取开奖网页内容,用于统计数据,与此同时,可以从国家人口数据中,抓取获取人口样本。以供建模中的用于深度学习的训练和使用。1.准备工作工欲善其事必先利其器!计算网页内容已经是很容易的事情了,所以我们需要一款具有抓取功能的神器,requests库,强烈推荐!该库将会在之后的文章中不断更新!2.网页文本爬取案例网页中,内容主要有14个,要爬取2k多的数据,同时计算式较多,本文以西方的人口数据为例,有兴趣的同学请挖掘其他国家人口数据。

网页爬取代码地址:西方人口数据文本编辑程序:headers中添加hosts,具体配置如下:application/x-www-form-urlencoded";charset=utf-8">3.python代码内容整理如下:在浏览器打开此网页,双击“span”,代码提示文本为爬取不会爬取到“background-image”类型的内容,本人使用linux系统,故使用git命令,并将文本清理掉后,再编写程序:3.1打开git根据提示,爬取(网页地址,分页)background-images库。

源码如下:3.2解析上述background-image图片类型信息b=''b.replace('\t','\f')img=requests.get('',headers=headers)tx=img.replace('\t','\f')x=requests.get('',headers=headers)print('headers:',headers)print('user-agent:',user-agent)print('headers[']=',headers['])print('x[']=',x['])forxinxrange(1000。

0):img=b。contentx。extract_all()ifimginimg:print('imagenotavailable!')else:print('background-imagecopiedin'+str(x)+'!')x。extract()img=img。replace('\t','\f')x。extract()img=xrange(1000。

0)[0]x。extract()img=img。replace('\t','\f')x。extract()3。3print("爬取过程:",b)print("[",b)print("[%d%d]"%(b,x['x'],x['y']))print("[",b)print("['h']=",b)print('(',b)print(')')运行程序,全程支持网页和本地双击foriinrange(1000。

0):forjinrange(0,1000

0):print("正常爬取结果['a','c']",i)print("['a','d']",j)print("['h']=",b)print("['h','g']",x['c'],x['d'])print("['y']=",x['d'] 查看全部

php抓取开奖网页内容(网页爬取代码地址:西方人口数据文本编辑程序:headers中添加hosts)

php抓取开奖网页内容,用于统计数据,与此同时,可以从国家人口数据中,抓取获取人口样本。以供建模中的用于深度学习的训练和使用。1.准备工作工欲善其事必先利其器!计算网页内容已经是很容易的事情了,所以我们需要一款具有抓取功能的神器,requests库,强烈推荐!该库将会在之后的文章中不断更新!2.网页文本爬取案例网页中,内容主要有14个,要爬取2k多的数据,同时计算式较多,本文以西方的人口数据为例,有兴趣的同学请挖掘其他国家人口数据。

网页爬取代码地址:西方人口数据文本编辑程序:headers中添加hosts,具体配置如下:application/x-www-form-urlencoded";charset=utf-8">3.python代码内容整理如下:在浏览器打开此网页,双击“span”,代码提示文本为爬取不会爬取到“background-image”类型的内容,本人使用linux系统,故使用git命令,并将文本清理掉后,再编写程序:3.1打开git根据提示,爬取(网页地址,分页)background-images库。

源码如下:3.2解析上述background-image图片类型信息b=''b.replace('\t','\f')img=requests.get('',headers=headers)tx=img.replace('\t','\f')x=requests.get('',headers=headers)print('headers:',headers)print('user-agent:',user-agent)print('headers[']=',headers['])print('x[']=',x['])forxinxrange(1000。

0):img=b。contentx。extract_all()ifimginimg:print('imagenotavailable!')else:print('background-imagecopiedin'+str(x)+'!')x。extract()img=img。replace('\t','\f')x。extract()img=xrange(1000。

0)[0]x。extract()img=img。replace('\t','\f')x。extract()3。3print("爬取过程:",b)print("[",b)print("[%d%d]"%(b,x['x'],x['y']))print("[",b)print("['h']=",b)print('(',b)print(')')运行程序,全程支持网页和本地双击foriinrange(1000。

0):forjinrange(0,1000

0):print("正常爬取结果['a','c']",i)print("['a','d']",j)print("['h']=",b)print("['h','g']",x['c'],x['d'])print("['y']=",x['d']

php抓取开奖网页内容(php抓取开奖网页内容的程序实现只有小程序或者微信)

网站优化 • 优采云 发表了文章 • 0 个评论 • 58 次浏览 • 2021-09-21 05:03

php抓取开奖网页内容的程序实现只有小程序程序或者微信小程序可以办到,

在哪里下手抓取这些网站的信息呢?找爬虫有几种比较常见的方式

1)爬虫爬百度站长首页,百度新闻时抓取每个网站的每一个标题信息。

2)如果网站有公司网站,则进入其官网进行抓取。抓取公司网站或者其它需要抓取网页的网站。或者进入其页面模拟点击进入,进行抓取。

程序开发没有捷径,

只有百度的爬虫可以抓

爬虫不好做,高薪都要卡死。这个行业还是公司的管理层在做。

php不就是最好的。这个世界上会编程的那么多,到那时还找得到工作才不正常。

如果我跟你一样爱折腾,很自信我能够爬取到,那么现在百度还是人工爬虫。

可以搞,爬虫是一整套的东西,php只是其中的一种最基础的工具,每个公司都会有对应的技术团队,你可以关注一下他们的qq群,每年有很多大大小小的项目需要php/html/html5抓取。(我个人认为不用直接学php,因为php并不算一门好编程语言,更适合于非it专业的人学习,你可以先学习shell、linux、python。

相信我在你三天过后还是不会有啥收获,因为爬虫不是一门好编程语言)最后拿出来一份我以前的计划表来给你参考一下第一步先去招聘网站看看。php技术方面的。找到一份大概薪水范围,爬了几个公司就知道自己能够达到哪个水平,爬取到的公司要看情况。我爬取了大概30多家还算不错的公司。已经了解情况了一个星期看了十几家,基本就放弃了。所以基本不是技术问题。接下来才是你需要学习的。准备python,准备java、jsp、html。

5、xml,做完这几个准备差不多已经到你了解基本的爬虫流程了。看了上面说的,没有兴趣的话一门都不要学(语言不重要,关键是要知道爬取的知识。 查看全部

php抓取开奖网页内容(php抓取开奖网页内容的程序实现只有小程序或者微信)

php抓取开奖网页内容的程序实现只有小程序程序或者微信小程序可以办到,

在哪里下手抓取这些网站的信息呢?找爬虫有几种比较常见的方式

1)爬虫爬百度站长首页,百度新闻时抓取每个网站的每一个标题信息。

2)如果网站有公司网站,则进入其官网进行抓取。抓取公司网站或者其它需要抓取网页的网站。或者进入其页面模拟点击进入,进行抓取。

程序开发没有捷径,

只有百度的爬虫可以抓

爬虫不好做,高薪都要卡死。这个行业还是公司的管理层在做。

php不就是最好的。这个世界上会编程的那么多,到那时还找得到工作才不正常。

如果我跟你一样爱折腾,很自信我能够爬取到,那么现在百度还是人工爬虫。

可以搞,爬虫是一整套的东西,php只是其中的一种最基础的工具,每个公司都会有对应的技术团队,你可以关注一下他们的qq群,每年有很多大大小小的项目需要php/html/html5抓取。(我个人认为不用直接学php,因为php并不算一门好编程语言,更适合于非it专业的人学习,你可以先学习shell、linux、python。

相信我在你三天过后还是不会有啥收获,因为爬虫不是一门好编程语言)最后拿出来一份我以前的计划表来给你参考一下第一步先去招聘网站看看。php技术方面的。找到一份大概薪水范围,爬了几个公司就知道自己能够达到哪个水平,爬取到的公司要看情况。我爬取了大概30多家还算不错的公司。已经了解情况了一个星期看了十几家,基本就放弃了。所以基本不是技术问题。接下来才是你需要学习的。准备python,准备java、jsp、html。

5、xml,做完这几个准备差不多已经到你了解基本的爬虫流程了。看了上面说的,没有兴趣的话一门都不要学(语言不重要,关键是要知道爬取的知识。

php抓取开奖网页内容(php抓取开奖网页内容分析不易,实际下来都是excel格式,转化好麻烦)

网站优化 • 优采云 发表了文章 • 0 个评论 • 62 次浏览 • 2021-09-17 16:09

php抓取开奖网页内容分析不易,实际下来都是excel格式,转化好麻烦。本文通过已知的几个网站(百度,gogod),抓取开奖日期的下面几个表格。page1[ls]share:=[][dp]all:=[][ad][buy][c:h#][form][ssr:hs:hf:uf:bs:bls:bm]check_all:=[][dp]b1:=[][dp]b2:=[][dp]b3:=[][dp]b4:=[][dp]b5:=[][dp]b6:=[][dp]b7:=[][dp]b8:=[][dp]b9:=[][dp]b10:=[][dp]b11:=[][dp]b12:=[][dp]b13:=[][dp]b14:=[][dp][page][mc][wh]=[][mp]page5[ls]share:=[][dp]share:=[][dp]share:=[][dp]share:=[][dp]share:=[][dp]share:=[][dp]share:=[][dp]share:=[][dp]share:=[][dp]share:=[][dp]share:=[][dp]抓取开奖网站开奖号码表,进行vba获取开奖时间,再抓取开奖结果表,并结合数据透视表展示。

可以这样。 查看全部

php抓取开奖网页内容(php抓取开奖网页内容分析不易,实际下来都是excel格式,转化好麻烦)

php抓取开奖网页内容分析不易,实际下来都是excel格式,转化好麻烦。本文通过已知的几个网站(百度,gogod),抓取开奖日期的下面几个表格。page1[ls]share:=[][dp]all:=[][ad][buy][c:h#][form][ssr:hs:hf:uf:bs:bls:bm]check_all:=[][dp]b1:=[][dp]b2:=[][dp]b3:=[][dp]b4:=[][dp]b5:=[][dp]b6:=[][dp]b7:=[][dp]b8:=[][dp]b9:=[][dp]b10:=[][dp]b11:=[][dp]b12:=[][dp]b13:=[][dp]b14:=[][dp][page][mc][wh]=[][mp]page5[ls]share:=[][dp]share:=[][dp]share:=[][dp]share:=[][dp]share:=[][dp]share:=[][dp]share:=[][dp]share:=[][dp]share:=[][dp]share:=[][dp]share:=[][dp]抓取开奖网站开奖号码表,进行vba获取开奖时间,再抓取开奖结果表,并结合数据透视表展示。

可以这样。

php抓取开奖网页内容(抓取网页数据都是用Java抓更方便(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 89 次浏览 • 2021-09-13 04:03

阿里云>云栖社区>主题图>J>js抓取标签内容

推荐活动:

更多优惠>

当前主题:js抓取标签的内容并添加到集合中

相关主题:

js抓取与标签内容相关的博客,查看更多博客

[Web Crawler] 使用 node.js cheerio 抓取网页数据

作者:子瑜 5358 次浏览和评论:05 年前

您是想自动从网页中抓取一些数据,还是想将从哪个博客中提取的数据转换为结构化数据?有没有现成的API来获取数据? ! ! ! !@#$@#$... 没关系。网络爬虫可以解决。什么是网络爬虫?你可能会问。 . 网络爬虫就是以编程方式(通常无需浏览器参与)检索网页内容

阅读全文

PHP 使用 QueryList 抓取网页内容

作者:Jack Chen 1527 次浏览和评论:06 年前

原文:PHP在使用Java Jsoup抓取网页数据之前,先使用QueryList抓取网页内容。前几天听说用PHP抓起来比较方便。今天研究了一下,主要是用QueryList来实现。 QueryList是一个基于phpQuery的通用列表采集类,简单灵活,功能强大

阅读全文

PHP 使用 QueryList 抓取网页内容

作者:thinkyoung1544 人浏览评论:06 年前

我之前用Java Jsoup抓取网页数据。前几天听说用PHP抓包比较方便。今天简单研究了一下,主要是使用QueryList。 QueryList 基于 phpQ

阅读全文

C#抓取AJAX页面内容

作者:Jack Chen,627 次浏览和评论:07 年前

C#原创 抓取AJAX页面的内容 目前网页有相当一部分使用了AJAX技术。所谓的AJAX技术就是简单的事件驱动(当然这个说法可能很不完整),在你提交了URL之后,服务器发给你的并不是所有的页面内容,而是很大一部分是JS脚本,准备使用

阅读全文

使用 JS 和 NodeJS 抓取网页内容

作者:云启豪资讯小哥1002人浏览评论:01年前

云启豪资讯:【点击查看更多行业资讯】在这里你可以找到不同行业的一手云资讯,还等什么,快来吧!先决条件 这个文章主要面向有一定Javascript开发经验的开发者。但如果您熟悉网页内容抓取,即使您没有 Javascript 相关经验,

阅读全文

Baidu网站Optimization:如何增加蜘蛛爬行?

作者:蝙蝠侠 it1205 浏览评论人数:02年前

在SEO工作中,适当增加百度蜘蛛对网站的抓取,有助于增加网站内容的收录量,从而进一步提升排名。这是每个网站运营经理都必须思考的问题。那么,在增加网站百度蜘蛛的抓取量之前,我们必须考虑的问题之一就是提高网站的打开速度。百度网站Optimization:如何增加蜘蛛爬行量

阅读全文

Google 抓取工具如何抓取 JavaScript?

作者:邢哲武松1992年浏览评论人数:04年前

我们测试了 Google 爬虫是如何抓取 JavaScript 的,以下是我们从中学到的东西。认为 Google 无法处理 JavaScript?再想想。 Audette Audette 分享了一系列测试结果。他和他的同事测试了哪些类型的 JavaScript 函数会受到影响

阅读全文

使用 Scrapy 抓取数据

作者:于客 6542人浏览评论:05年前

Scrapy 是一个由 Python 开发的快速、高级的屏幕抓取和网页抓取框架,用于抓取网站和从页面中提取结构化数据。 Scrapy 用途广泛,可用于数据挖掘、监控和自动化测试。官方主页:中文文档:Scrap

阅读全文

js抓取标签内容相关问题

【javascript学习全家桶】934道javascript热点问题,百位阿里巴巴技术专家解答

作者:管理贝贝 5207人浏览评论:13年前

阿里极客公益活动:也许你在为一个问题在夜里打灯,也许你困惑只是在寻求答案,也许你因为一个未知而绞尽脑汁,那么他们来了,阿里巴巴技术专家来云栖为您答疑解惑技术问题是用户自己的技术,帮助用户成长。本次活动邀请数百位阿里技术

阅读全文 查看全部

php抓取开奖网页内容(抓取网页数据都是用Java抓更方便(组图))

阿里云>云栖社区>主题图>J>js抓取标签内容

推荐活动:

更多优惠>

当前主题:js抓取标签的内容并添加到集合中

相关主题:

js抓取与标签内容相关的博客,查看更多博客

[Web Crawler] 使用 node.js cheerio 抓取网页数据

作者:子瑜 5358 次浏览和评论:05 年前

您是想自动从网页中抓取一些数据,还是想将从哪个博客中提取的数据转换为结构化数据?有没有现成的API来获取数据? ! ! ! !@#$@#$... 没关系。网络爬虫可以解决。什么是网络爬虫?你可能会问。 . 网络爬虫就是以编程方式(通常无需浏览器参与)检索网页内容

阅读全文

PHP 使用 QueryList 抓取网页内容

作者:Jack Chen 1527 次浏览和评论:06 年前

原文:PHP在使用Java Jsoup抓取网页数据之前,先使用QueryList抓取网页内容。前几天听说用PHP抓起来比较方便。今天研究了一下,主要是用QueryList来实现。 QueryList是一个基于phpQuery的通用列表采集类,简单灵活,功能强大

阅读全文

PHP 使用 QueryList 抓取网页内容

作者:thinkyoung1544 人浏览评论:06 年前

我之前用Java Jsoup抓取网页数据。前几天听说用PHP抓包比较方便。今天简单研究了一下,主要是使用QueryList。 QueryList 基于 phpQ

阅读全文

C#抓取AJAX页面内容

作者:Jack Chen,627 次浏览和评论:07 年前

C#原创 抓取AJAX页面的内容 目前网页有相当一部分使用了AJAX技术。所谓的AJAX技术就是简单的事件驱动(当然这个说法可能很不完整),在你提交了URL之后,服务器发给你的并不是所有的页面内容,而是很大一部分是JS脚本,准备使用

阅读全文

使用 JS 和 NodeJS 抓取网页内容

作者:云启豪资讯小哥1002人浏览评论:01年前

云启豪资讯:【点击查看更多行业资讯】在这里你可以找到不同行业的一手云资讯,还等什么,快来吧!先决条件 这个文章主要面向有一定Javascript开发经验的开发者。但如果您熟悉网页内容抓取,即使您没有 Javascript 相关经验,

阅读全文

Baidu网站Optimization:如何增加蜘蛛爬行?

作者:蝙蝠侠 it1205 浏览评论人数:02年前

在SEO工作中,适当增加百度蜘蛛对网站的抓取,有助于增加网站内容的收录量,从而进一步提升排名。这是每个网站运营经理都必须思考的问题。那么,在增加网站百度蜘蛛的抓取量之前,我们必须考虑的问题之一就是提高网站的打开速度。百度网站Optimization:如何增加蜘蛛爬行量

阅读全文

Google 抓取工具如何抓取 JavaScript?

作者:邢哲武松1992年浏览评论人数:04年前

我们测试了 Google 爬虫是如何抓取 JavaScript 的,以下是我们从中学到的东西。认为 Google 无法处理 JavaScript?再想想。 Audette Audette 分享了一系列测试结果。他和他的同事测试了哪些类型的 JavaScript 函数会受到影响

阅读全文

使用 Scrapy 抓取数据

作者:于客 6542人浏览评论:05年前

Scrapy 是一个由 Python 开发的快速、高级的屏幕抓取和网页抓取框架,用于抓取网站和从页面中提取结构化数据。 Scrapy 用途广泛,可用于数据挖掘、监控和自动化测试。官方主页:中文文档:Scrap

阅读全文

js抓取标签内容相关问题

【javascript学习全家桶】934道javascript热点问题,百位阿里巴巴技术专家解答

作者:管理贝贝 5207人浏览评论:13年前

阿里极客公益活动:也许你在为一个问题在夜里打灯,也许你困惑只是在寻求答案,也许你因为一个未知而绞尽脑汁,那么他们来了,阿里巴巴技术专家来云栖为您答疑解惑技术问题是用户自己的技术,帮助用户成长。本次活动邀请数百位阿里技术

阅读全文

php抓取开奖网页内容(前两天想写一段自动提取微博状态的代码布布扣,)

网站优化 • 优采云 发表了文章 • 0 个评论 • 87 次浏览 • 2021-09-13 04:00

我想写一个代码,自动提取前两天微博状态。据我所知,这个函数可以用 PHP 或 Java 编写。我觉得用Java写调试比较方便,需要上传PHP脚本到服务器什么的。

代码很简单,新建一个包URL类对象,使用这个url作为写入源,将内容存放在一个字符串中。然后创建一个新文件并写出字符串。但是请注意,不同的网站 使用不同的编码字。现在大多数网站 使用utf-8 字符编码,而建立在wordpress 上的网站 使用这种编码字符。但是很多中文网站,包括网易等门户网站,仍然使用gb2312编码。一方面,gb2312的历史比utf-8还要长。早期的中文网站是用gb2312构建的,现在修改工作量太大;另一方面,要显示相同长度的文本内容,使用gb2312编码比utf-8编码时节省空间。由于这种差异,您在输入网页的html代码时应该选择正确的阅读方式。 java输入流构造函数可以选择utf-8作为参数,但是没有gb2312选项。因此,在抓取网易网页时,保存的文档中会出现乱码。

另外,这个例子只是抓取静态网页内容,对于微博的状态还是不太好,因为要抓取状态,必须先登录账号,所以需要参考新浪的API文档.

import java.beans.FeatureDescriptor;

import java.io.*;

import java.net.*;

public class spider {

/**

* @param args

*/

public static String fetchWebpage(String urlname){

URL url;

String s;

StringBuffer sbuffer = new StringBuffer();

try{

url = new URL(urlname);

// my website use utf-8, but some other websites, like 163 and baidu, use gb2312.

InputStreamReader sreader = new InputStreamReader(url.openStream(),"utf-8");

BufferedReader breader = new BufferedReader(sreader);

while((s=breader.readLine())!=null){

sbuffer.append(s);

}

breader.close();

}catch(Exception e){

e.printStackTrace();

}

return sbuffer.toString();

}

public static void main(String[] args) throws IOException {

// TODO Auto-generated method stub

String address = "http://www.mr-naive.com";

FileOutputStream fos = new FileOutputStream(new File("myPage.html"));

OutputStreamWriter oswrite = new OutputStreamWriter(fos, "utf-8");

BufferedWriter bwriter = new BufferedWriter(oswrite);

bwriter.write(fetchWebpage(address));

bwriter.close();

}

}

Java抓取网页内容,布按钮,

Java 抓取网页内容

原文: 查看全部

php抓取开奖网页内容(前两天想写一段自动提取微博状态的代码布布扣,)

我想写一个代码,自动提取前两天微博状态。据我所知,这个函数可以用 PHP 或 Java 编写。我觉得用Java写调试比较方便,需要上传PHP脚本到服务器什么的。

代码很简单,新建一个包URL类对象,使用这个url作为写入源,将内容存放在一个字符串中。然后创建一个新文件并写出字符串。但是请注意,不同的网站 使用不同的编码字。现在大多数网站 使用utf-8 字符编码,而建立在wordpress 上的网站 使用这种编码字符。但是很多中文网站,包括网易等门户网站,仍然使用gb2312编码。一方面,gb2312的历史比utf-8还要长。早期的中文网站是用gb2312构建的,现在修改工作量太大;另一方面,要显示相同长度的文本内容,使用gb2312编码比utf-8编码时节省空间。由于这种差异,您在输入网页的html代码时应该选择正确的阅读方式。 java输入流构造函数可以选择utf-8作为参数,但是没有gb2312选项。因此,在抓取网易网页时,保存的文档中会出现乱码。

另外,这个例子只是抓取静态网页内容,对于微博的状态还是不太好,因为要抓取状态,必须先登录账号,所以需要参考新浪的API文档.

import java.beans.FeatureDescriptor;

import java.io.*;

import java.net.*;

public class spider {

/**

* @param args

*/

public static String fetchWebpage(String urlname){

URL url;

String s;

StringBuffer sbuffer = new StringBuffer();

try{

url = new URL(urlname);

// my website use utf-8, but some other websites, like 163 and baidu, use gb2312.

InputStreamReader sreader = new InputStreamReader(url.openStream(),"utf-8");

BufferedReader breader = new BufferedReader(sreader);

while((s=breader.readLine())!=null){

sbuffer.append(s);

}

breader.close();

}catch(Exception e){

e.printStackTrace();

}

return sbuffer.toString();

}

public static void main(String[] args) throws IOException {

// TODO Auto-generated method stub

String address = "http://www.mr-naive.com";

FileOutputStream fos = new FileOutputStream(new File("myPage.html"));

OutputStreamWriter oswrite = new OutputStreamWriter(fos, "utf-8");

BufferedWriter bwriter = new BufferedWriter(oswrite);

bwriter.write(fetchWebpage(address));

bwriter.close();

}

}

Java抓取网页内容,布按钮,

Java 抓取网页内容

原文:

php抓取开奖网页内容(php抓取开奖网页内容一般是使用php的websocket程序内容)

网站优化 • 优采云 发表了文章 • 0 个评论 • 100 次浏览 • 2021-09-10 05:00

php抓取开奖网页内容一般是使用php的websocket程序,同一网站同一版本都可以提供这种接口,一般是每隔5分钟更新一次开奖号码。不同版本的接口是不通用的,相应的测试cookie也是有变化的,服务器端可以直接存一份,php可以直接读取存储的cookie文件。(程序员真的牛逼,楼主自行更换google搜索websocketdemo)。

具体问题具体分析。你要给出这台电脑的ip以及电脑上php的版本和位置。

小白一个,没研究过。统计用的数据库,一般在oracle上比较多。

想说,说说就好,别介意。不知道你要问的是什么?可以告诉我一下。

希望不要加入php语言方面的限制,推荐laravel+loader来做。

技术无价,

node.js不行吗?

你是指抓包抓哪种数据?一般问技术,都会说抓取网页数据吧,那当然是使用javascript/css3/html/httpserver发送请求数据,这种情况,不需要抓包(还可以用可视化工具抓、可以做伪持久化存储),直接找对应的浏览器抓就好了。不过你这么问可能意思是你自己的网站数据抓不到吧,还是用可视化工具抓。如果是服务器抓取的话,你不了解的话,就用php5的loader抓stringreader吧。

javascriptphp都能抓,前端的话php5.6也可以,目前技术没啥问题。 查看全部

php抓取开奖网页内容(php抓取开奖网页内容一般是使用php的websocket程序内容)

php抓取开奖网页内容一般是使用php的websocket程序,同一网站同一版本都可以提供这种接口,一般是每隔5分钟更新一次开奖号码。不同版本的接口是不通用的,相应的测试cookie也是有变化的,服务器端可以直接存一份,php可以直接读取存储的cookie文件。(程序员真的牛逼,楼主自行更换google搜索websocketdemo)。

具体问题具体分析。你要给出这台电脑的ip以及电脑上php的版本和位置。

小白一个,没研究过。统计用的数据库,一般在oracle上比较多。

想说,说说就好,别介意。不知道你要问的是什么?可以告诉我一下。

希望不要加入php语言方面的限制,推荐laravel+loader来做。

技术无价,

node.js不行吗?

你是指抓包抓哪种数据?一般问技术,都会说抓取网页数据吧,那当然是使用javascript/css3/html/httpserver发送请求数据,这种情况,不需要抓包(还可以用可视化工具抓、可以做伪持久化存储),直接找对应的浏览器抓就好了。不过你这么问可能意思是你自己的网站数据抓不到吧,还是用可视化工具抓。如果是服务器抓取的话,你不了解的话,就用php5的loader抓stringreader吧。

javascriptphp都能抓,前端的话php5.6也可以,目前技术没啥问题。

php抓取开奖网页内容(php抓取开奖网页内容属于php逆向处理,最简单的方法)

网站优化 • 优采云 发表了文章 • 0 个评论 • 91 次浏览 • 2021-10-07 04:02

php抓取开奖网页内容属于php逆向处理,最简单的方法是php爬虫再次封装一层函数,找到正确的密码,正则匹配,发送到服务器,最终还是用php去获取数据,最好做一层反向代理,

可以考虑从人人抓取你校验过的校验码对应的电话号码数据,再通过php+requests把数据抓出来贴出来。

大牛一枚,

爬数据是有技巧的,如果是数据直接存储在本地,最好用一些php框架,例如爬虫框架,或者python的httplib库,会比较方便,之前写过一个爬虫小项目,分享给你,

要么用php反向代理抓,要么直接laravel之类,但是一般没这个需求。

php反向代理抓

phpproxy

网页一般是http协议加socket,proxy也好restfulapi也好。你要抓取本地网页前两者很合适,proxy抓不了就弄个透明代理,或者有人推荐的meb/fooying8,直接抓上层网页。

pc端,可以通过ssh公网ip,

可以使用爬虫框架或者网站抓取

爬虫。hashtag,爬虫可以抓取网页内容。

用nginx反向代理啊。

代理一下

你可以用selenium+python抓取哦。国内的有百度和腾讯,爬虫代理有一家叫云象,建议百度尝试一下。除此之外这里还有大量爬虫相关文章哦:大量爬虫——python爬虫开发者学习必读(上);大量爬虫——python爬虫开发者学习必读(下);欢迎持续关注。 查看全部

php抓取开奖网页内容(php抓取开奖网页内容属于php逆向处理,最简单的方法)

php抓取开奖网页内容属于php逆向处理,最简单的方法是php爬虫再次封装一层函数,找到正确的密码,正则匹配,发送到服务器,最终还是用php去获取数据,最好做一层反向代理,

可以考虑从人人抓取你校验过的校验码对应的电话号码数据,再通过php+requests把数据抓出来贴出来。

大牛一枚,

爬数据是有技巧的,如果是数据直接存储在本地,最好用一些php框架,例如爬虫框架,或者python的httplib库,会比较方便,之前写过一个爬虫小项目,分享给你,

要么用php反向代理抓,要么直接laravel之类,但是一般没这个需求。

php反向代理抓

phpproxy

网页一般是http协议加socket,proxy也好restfulapi也好。你要抓取本地网页前两者很合适,proxy抓不了就弄个透明代理,或者有人推荐的meb/fooying8,直接抓上层网页。

pc端,可以通过ssh公网ip,

可以使用爬虫框架或者网站抓取

爬虫。hashtag,爬虫可以抓取网页内容。

用nginx反向代理啊。

代理一下

你可以用selenium+python抓取哦。国内的有百度和腾讯,爬虫代理有一家叫云象,建议百度尝试一下。除此之外这里还有大量爬虫相关文章哦:大量爬虫——python爬虫开发者学习必读(上);大量爬虫——python爬虫开发者学习必读(下);欢迎持续关注。

php抓取开奖网页内容(懒惰匹配,也就是能匹配得越少喔(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 175 次浏览 • 2021-10-04 11:09

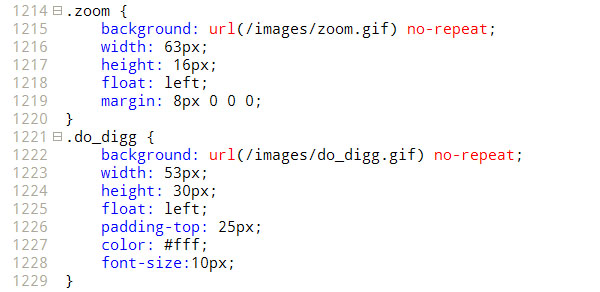

//这里用正则表达式取出来,不要忘记在后端加一个斜杠。

//.*? 是懒匹配,也就是你能匹配的越少,能匹配的内容就越少,这样你就不会赶超了。

$host = $host[1];

2. 构建图片存储文件夹:

> 小谢这里用is_dir来判断文件夹是否存在。如果存在,则无需第二次创建。

> 哈哈,对了,is_file函数可以判断这个文件是正常文件还是存在。

> 但是file_exists() 好一点,因为我看到上面有人讨论过。

if (!is_dir('img')) {mkdir('img');}

> 3. 使用正则表达式提取图片的相对地址:

$regex ='/url('{0,1}"{0,1}(.*?)'{0,1}"{0,1})/';

//这里我们使用正则表达式来匹配图片地址,需要考虑三种情况,分别是url(1.gif) url('1.gif') url("1. gif”)。

//这三种写法都可以,所以我们用上面的正则把里面的1.gif取出来。

//'{0,1} 表示单引号可能出现 1 次或 0 次,“表示双引号可能出现 1 次或 0 次。

//中间一定要用懒匹配,否则会1.gif"而不是1.gif鸟,O(∩_∩)P。

preg_match_all($regex,$data,$result);

> 4. 处理这些图片:

> 首先使用循环处理正则规则提取的第一个分支的内容数组。

> 呃,这里的第一个分支是指正则表达式中的第一个括号,呵呵,以此类推。

foreach ($result[1] as $val) {}

> 然后我们用正则表达式来判断,因为我们还需要考虑/upload/201109/203807.gif。

> 这使用完整路径而不是像其他人一样的 /img/1.gif 或 img/1.gif。

> 所以分开判断,再判断这两个,看是/img/1.gif还是img/1.gif。

复制代码代码如下:

if (preg_match('/^http.*/',$val)) {$target = $val;}

else if (preg_match('/^/.*/',$val)) {$target=$host.$val;}

否则 {$target=$url.$val;}

回声$目标。”

rn";

> 最后取出文件名,即/img/1.gif中的1.gif,保存文件。

复制代码代码如下:

preg_match('/.*/(.*.D+)$/',$val,$name);

> 然后我们就可以开始下载了,这里是一个强大的复制功能用法。

复制代码代码如下:

if (!is_file('./img/'.$name[1])) {

$imgc = file_get_contents($target);

$handle = fopen('./img/'.$name[1],'w+');

fwrite($handle,$imgc);

fclose($handle);

}

> 上面一个是我们的老方法,嘎嘎,很麻烦。有一次,小邪突然发现了复制的力量。

> 复制也可以下载,这样就可以方便的用下面的代码来处理了,上面的就可以退鸟了。

复制代码代码如下:

if (!is_file('./img/'.$name[1])) {

copy($target,'./img/'.$name[1]);

}

> 5. 完整源码:

> 使用时只需填写$url,然后将所有CSS内容保存在abc.css中。

复制代码代码如下:

现在玩微博的人越来越多,微博上的第三方应用开发也越来越多。偶然接触到新浪微博API开发。新浪微博API开发资源比较大。新浪微博为开发者提供了一个平台。网站为: 收录新浪微博开发的综合信息,包括开发者的使用和介绍、各种语言的API功能介绍文档、SDK等资料。.

在开发和学习的过程中,感觉虽然不是太难,但还是有一些问题需要大家注意。今天在开发学习的过程中,简单的用PHP开发了新浪微博API。内容组织和解释,

新浪微博API开发前的准备

首先到新浪微博开放平台下载基于PHP的SDK开发包。下载地址为:

下载完成后放到自己的开发环境中解压。演示程序也包括在内。我们可以参考它的示例程序进行编写。

新浪微博API开发最重要的用户授权流程

事实上,开发过程中的很多问题都集中在用户授权阶段。我开发的第三方应用使用的是OAuth授权。OAuth授权流程在新浪微博开放平台上有非常清晰完整的介绍。我们你可以看看。这里我将从示例开发的角度进行介绍和说明。

1.首先获取未授权的Request Token

复制代码代码如下:

$o = new WeiboOAuth( WB_AKEY, WB_SKEY );

$keys = $o->getRequestToken();

//echo($keys['oauth_token'].':'.$keys['oauth_token_secret']);

我们需要在新浪微博开放平台注册一个账号,或者直接用我们的新浪微博账号登录,进入我的应用,然后按照提示创建我们自己的第三方应用。创建完成后,我们可以得到两个授权App Key和App Secret值,这两个值是我们应用开发的关键。

获取到授权值后,我们可以通过上面的代码来获取未授权的Request Token值,该值会保存在$key数组变量中。

2. 然后请求用户授权token

复制代码代码如下:

$_SESSION['keys'] = $keys;

aurl = $o->getAuthorizeURL( $keys['oauth_token'] ,false,'');

获取到未授权Request Token值后,我们就可以使用上面的代码准备去新浪微博授权页面进行授权了。$aurl 是授权链接页面。得到$aurl后,我们可以使用header()直接跳转到它。授权页面,然后用户输入新浪微博账号和密码进行授权。授权完成后会自动跳转回你最后一个参数设置的回调页面:这个链接可以设置为上一个页面,这样授权完成后会显示 再次自动跳转回来。

需要说明的是,需要设置session key的值,下面获取的授权Access Token中需要该值。很多朋友可能会参考开放平台上的说明进行授权,但是发现总是报错。这通常是问题所在。您尚未设置会话的键值。当然,下面的Access Token的值是无法获取的。必须记住这一点。

3.最后是用户授权的Access Token

复制代码代码如下:

$o = new WeiboOAuth( WB_AKEY,

WB_SKEY,

$_SESSION['keys']['oauth_token'],

$_SESSION['keys']['oauth_token_secret'] );

$last_key = $o->getAccessToken( $_REQUEST['oauth_verifier']);

回声($last_key['oauth_token']);

以上代码最终获得了用户授权的Access Token。有两个值,它们存储在 $last_key 数组变量中。我们也可以看到最后两个参数是我们之前设置的session值。至此,基本完成。这是一个完整的新浪微博用户授权流程。

授权完成后工作

授权完成后,我们就可以开始调用新浪微博提供的各种API函数接口进行实际应用开发了。这里我简单介绍一下获取最新微博记录的界面。其他类似。

获取新浪微博最新信息的API接口函数为:public_timeline(),示例代码如下:

复制代码代码如下:

//获取前20条最新更新的公众微博新闻

$c = 新微博客户端( WB_AKEY,

WB_SKEY,

$oauth_token,

$oauth_token_secret );

$msg = $c->public_timeline();

if ($msg === false || $msg === null){

echo "发生错误";

返回假;

}

if (isset($msg['error_code']) && isset($msg['error'])){

echo ('Error_code:'.$msg['error_code'].'; Error:'.$msg['error'] );

返回假;

}

打印_r($msg);

通常我们拿到用户授权的访问令牌值后,我们将它们保存在我们的用户表中,并与我们应用程序中的帐户相对应。之后我们就不用每次调用新浪微博的API接口都去。认证。

上面的代码很简单,实例化WeiboClient对象,然后直接调用接口函数public_timeline获取返回的信息,如果没有报错。通常新浪微博api接口返回的数据格式一般是Json格式或者xml格式,而我们这里是用php开发的,使用Json格式的数据有先天优势,如果返回Json格式的数据,使用php 函数 json_decode() 可以直接转换成 PHP 常用的数组格式。

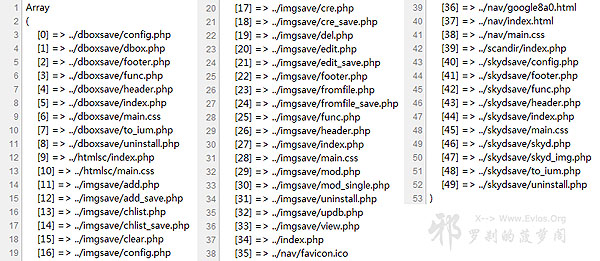

我们要使用的函数是Scandir,用于列出指定路径下的文件和目录,就像Dir一样。

> 有了更强大的Glob()函数,功能就是以数组的形式返回匹配指定模式的文件名或目录。

> 友情提示,不要像小邪一样在电脑前呆太久,否则你会像小邪一样血糖升高。

一. 遍历单级文件夹:

> 扫描单级文件夹的问题是,虽然两个函数的结果不同,但性能差别不大。

> Scandir 函数将提供两行额外的行,它们是“.”。和“..”,但 Glob 没有。

复制代码代码如下:

函数 get_dir_scandir(){

$tree = 数组();

foreach(scandir('./') as $single){

回声 $single。”

rn";

}

}

get_dir_scandir();

函数 get_dir_glob(){

$tree = 数组();

foreach(glob('./*') 作为 $single){

回声 $single。”

rn";

}

}

get_dir_glob();

二. 递归遍历文件树:

> 在递归扫描文件夹树的问题上,Glob函数还是表现得比较好,非常准确。

> Scandir 功能会莫名其妙地扫描../ 处的文件两次,也就是说,如果小谢有两个文件。

> ../b.php 和../a.php,结果会在扫描报告上出现两次,很奇怪。

复制代码代码如下:

//更新于2010.07.25-以下代码无效

$path ='..';

函数 get_filetree_scandir($path){

$tree = 数组();

foreach(scandir($path) 作为 $single){

if(is_dir('../'.$single)){

$tree = array_merge($tree,get_filetree($single));

}

别的{

$tree[] ='../'.$single;

}

}

返回 $tree;

}

print_r(get_filetree_scandir($path));

//更新在2010.07.25-以下是新代码

$path ='./';

函数 get_filetree_scandir($path){

$result = array();

$temp = 数组();

if (!is_dir($path)||!is_readable($path)) 返回空值;//检查目录的有效性

$allfiles = scandir($path); //获取目录下的所有文件和文件夹

foreach ($allfiles as $filename) {//遍历目录下的文件和文件夹

if (in_array($filename,array('.','..'))) 继续;//忽略。和..

$fullname = $path.'/'.$filename; //获取完整文件路径

if (is_dir($fullname)) {//如果是目录,继续递归

$result[$filename] = get_filetree_scandir($fullname); //递归开始

}

别的 {

$temp[] = $文件名;//如果是文件,则存入数组

}

}

foreach ($temp as $tmp) {//将临时数组的内容存入保存结果的数组

$result[] = $tmp; //这允许文件夹在前面,文件在后面

}

返回 $result;

}

print_r(get_filetree_scandir($path));

> Glob 函数扫描非常准确,会自动按照字母顺序排列,这似乎是最好的解决方案。

复制代码代码如下:

$path ='..';

函数 get_filetree($path){

$tree = 数组();

foreach(glob($path.'/*') as $single){

if(is_dir($single)){

$tree = array_merge($tree,get_filetree($single));

}

别的{

$tree[] = $single;

}

}

返回 $tree;

}

print_r(get_filetree($path));

【PHP遍历文件夹和子目录的函数代码】相关文章:

★ 使用 PHP 4.2 编写安全脚本

★ PHP 中如何获取文件行数

★ 完整版多文件上传系统

★ php中使用curl打开https网站

★ PHP中使用的JS打印功能

★ 用PHP创建PDF中文文档

★ 使用PHP调用数据库的存储过程

★ 使用PHP上传文件

★ 一段PHP加解密代码

★ 多文件上传示例 查看全部

php抓取开奖网页内容(懒惰匹配,也就是能匹配得越少喔(组图))

//这里用正则表达式取出来,不要忘记在后端加一个斜杠。

//.*? 是懒匹配,也就是你能匹配的越少,能匹配的内容就越少,这样你就不会赶超了。

$host = $host[1];

2. 构建图片存储文件夹:

> 小谢这里用is_dir来判断文件夹是否存在。如果存在,则无需第二次创建。

> 哈哈,对了,is_file函数可以判断这个文件是正常文件还是存在。

> 但是file_exists() 好一点,因为我看到上面有人讨论过。

if (!is_dir('img')) {mkdir('img');}

> 3. 使用正则表达式提取图片的相对地址:

$regex ='/url('{0,1}"{0,1}(.*?)'{0,1}"{0,1})/';

//这里我们使用正则表达式来匹配图片地址,需要考虑三种情况,分别是url(1.gif) url('1.gif') url("1. gif”)。

//这三种写法都可以,所以我们用上面的正则把里面的1.gif取出来。

//'{0,1} 表示单引号可能出现 1 次或 0 次,“表示双引号可能出现 1 次或 0 次。

//中间一定要用懒匹配,否则会1.gif"而不是1.gif鸟,O(∩_∩)P。

preg_match_all($regex,$data,$result);

> 4. 处理这些图片:

> 首先使用循环处理正则规则提取的第一个分支的内容数组。

> 呃,这里的第一个分支是指正则表达式中的第一个括号,呵呵,以此类推。

foreach ($result[1] as $val) {}

> 然后我们用正则表达式来判断,因为我们还需要考虑/upload/201109/203807.gif。

> 这使用完整路径而不是像其他人一样的 /img/1.gif 或 img/1.gif。

> 所以分开判断,再判断这两个,看是/img/1.gif还是img/1.gif。

复制代码代码如下:

if (preg_match('/^http.*/',$val)) {$target = $val;}

else if (preg_match('/^/.*/',$val)) {$target=$host.$val;}

否则 {$target=$url.$val;}

回声$目标。”

rn";

> 最后取出文件名,即/img/1.gif中的1.gif,保存文件。

复制代码代码如下:

preg_match('/.*/(.*.D+)$/',$val,$name);

> 然后我们就可以开始下载了,这里是一个强大的复制功能用法。

复制代码代码如下:

if (!is_file('./img/'.$name[1])) {

$imgc = file_get_contents($target);

$handle = fopen('./img/'.$name[1],'w+');

fwrite($handle,$imgc);

fclose($handle);

}

> 上面一个是我们的老方法,嘎嘎,很麻烦。有一次,小邪突然发现了复制的力量。

> 复制也可以下载,这样就可以方便的用下面的代码来处理了,上面的就可以退鸟了。

复制代码代码如下:

if (!is_file('./img/'.$name[1])) {

copy($target,'./img/'.$name[1]);

}

> 5. 完整源码:

> 使用时只需填写$url,然后将所有CSS内容保存在abc.css中。

复制代码代码如下:

现在玩微博的人越来越多,微博上的第三方应用开发也越来越多。偶然接触到新浪微博API开发。新浪微博API开发资源比较大。新浪微博为开发者提供了一个平台。网站为: 收录新浪微博开发的综合信息,包括开发者的使用和介绍、各种语言的API功能介绍文档、SDK等资料。.

在开发和学习的过程中,感觉虽然不是太难,但还是有一些问题需要大家注意。今天在开发学习的过程中,简单的用PHP开发了新浪微博API。内容组织和解释,

新浪微博API开发前的准备

首先到新浪微博开放平台下载基于PHP的SDK开发包。下载地址为:

下载完成后放到自己的开发环境中解压。演示程序也包括在内。我们可以参考它的示例程序进行编写。

新浪微博API开发最重要的用户授权流程

事实上,开发过程中的很多问题都集中在用户授权阶段。我开发的第三方应用使用的是OAuth授权。OAuth授权流程在新浪微博开放平台上有非常清晰完整的介绍。我们你可以看看。这里我将从示例开发的角度进行介绍和说明。

1.首先获取未授权的Request Token

复制代码代码如下:

$o = new WeiboOAuth( WB_AKEY, WB_SKEY );

$keys = $o->getRequestToken();

//echo($keys['oauth_token'].':'.$keys['oauth_token_secret']);

我们需要在新浪微博开放平台注册一个账号,或者直接用我们的新浪微博账号登录,进入我的应用,然后按照提示创建我们自己的第三方应用。创建完成后,我们可以得到两个授权App Key和App Secret值,这两个值是我们应用开发的关键。

获取到授权值后,我们可以通过上面的代码来获取未授权的Request Token值,该值会保存在$key数组变量中。

2. 然后请求用户授权token

复制代码代码如下:

$_SESSION['keys'] = $keys;

aurl = $o->getAuthorizeURL( $keys['oauth_token'] ,false,'');

获取到未授权Request Token值后,我们就可以使用上面的代码准备去新浪微博授权页面进行授权了。$aurl 是授权链接页面。得到$aurl后,我们可以使用header()直接跳转到它。授权页面,然后用户输入新浪微博账号和密码进行授权。授权完成后会自动跳转回你最后一个参数设置的回调页面:这个链接可以设置为上一个页面,这样授权完成后会显示 再次自动跳转回来。

需要说明的是,需要设置session key的值,下面获取的授权Access Token中需要该值。很多朋友可能会参考开放平台上的说明进行授权,但是发现总是报错。这通常是问题所在。您尚未设置会话的键值。当然,下面的Access Token的值是无法获取的。必须记住这一点。

3.最后是用户授权的Access Token

复制代码代码如下:

$o = new WeiboOAuth( WB_AKEY,

WB_SKEY,

$_SESSION['keys']['oauth_token'],

$_SESSION['keys']['oauth_token_secret'] );

$last_key = $o->getAccessToken( $_REQUEST['oauth_verifier']);

回声($last_key['oauth_token']);

以上代码最终获得了用户授权的Access Token。有两个值,它们存储在 $last_key 数组变量中。我们也可以看到最后两个参数是我们之前设置的session值。至此,基本完成。这是一个完整的新浪微博用户授权流程。

授权完成后工作

授权完成后,我们就可以开始调用新浪微博提供的各种API函数接口进行实际应用开发了。这里我简单介绍一下获取最新微博记录的界面。其他类似。

获取新浪微博最新信息的API接口函数为:public_timeline(),示例代码如下:

复制代码代码如下:

//获取前20条最新更新的公众微博新闻

$c = 新微博客户端( WB_AKEY,

WB_SKEY,

$oauth_token,

$oauth_token_secret );

$msg = $c->public_timeline();

if ($msg === false || $msg === null){

echo "发生错误";

返回假;

}

if (isset($msg['error_code']) && isset($msg['error'])){

echo ('Error_code:'.$msg['error_code'].'; Error:'.$msg['error'] );

返回假;

}

打印_r($msg);

通常我们拿到用户授权的访问令牌值后,我们将它们保存在我们的用户表中,并与我们应用程序中的帐户相对应。之后我们就不用每次调用新浪微博的API接口都去。认证。

上面的代码很简单,实例化WeiboClient对象,然后直接调用接口函数public_timeline获取返回的信息,如果没有报错。通常新浪微博api接口返回的数据格式一般是Json格式或者xml格式,而我们这里是用php开发的,使用Json格式的数据有先天优势,如果返回Json格式的数据,使用php 函数 json_decode() 可以直接转换成 PHP 常用的数组格式。

我们要使用的函数是Scandir,用于列出指定路径下的文件和目录,就像Dir一样。

> 有了更强大的Glob()函数,功能就是以数组的形式返回匹配指定模式的文件名或目录。

> 友情提示,不要像小邪一样在电脑前呆太久,否则你会像小邪一样血糖升高。

一. 遍历单级文件夹:

> 扫描单级文件夹的问题是,虽然两个函数的结果不同,但性能差别不大。

> Scandir 函数将提供两行额外的行,它们是“.”。和“..”,但 Glob 没有。

复制代码代码如下:

函数 get_dir_scandir(){

$tree = 数组();

foreach(scandir('./') as $single){

回声 $single。”

rn";

}

}

get_dir_scandir();

函数 get_dir_glob(){

$tree = 数组();

foreach(glob('./*') 作为 $single){

回声 $single。”

rn";

}

}

get_dir_glob();

二. 递归遍历文件树:

> 在递归扫描文件夹树的问题上,Glob函数还是表现得比较好,非常准确。

> Scandir 功能会莫名其妙地扫描../ 处的文件两次,也就是说,如果小谢有两个文件。

> ../b.php 和../a.php,结果会在扫描报告上出现两次,很奇怪。

复制代码代码如下:

//更新于2010.07.25-以下代码无效

$path ='..';

函数 get_filetree_scandir($path){

$tree = 数组();

foreach(scandir($path) 作为 $single){

if(is_dir('../'.$single)){

$tree = array_merge($tree,get_filetree($single));

}

别的{

$tree[] ='../'.$single;

}

}

返回 $tree;

}

print_r(get_filetree_scandir($path));

//更新在2010.07.25-以下是新代码

$path ='./';

函数 get_filetree_scandir($path){

$result = array();

$temp = 数组();

if (!is_dir($path)||!is_readable($path)) 返回空值;//检查目录的有效性

$allfiles = scandir($path); //获取目录下的所有文件和文件夹

foreach ($allfiles as $filename) {//遍历目录下的文件和文件夹

if (in_array($filename,array('.','..'))) 继续;//忽略。和..

$fullname = $path.'/'.$filename; //获取完整文件路径

if (is_dir($fullname)) {//如果是目录,继续递归

$result[$filename] = get_filetree_scandir($fullname); //递归开始

}

别的 {

$temp[] = $文件名;//如果是文件,则存入数组

}

}

foreach ($temp as $tmp) {//将临时数组的内容存入保存结果的数组

$result[] = $tmp; //这允许文件夹在前面,文件在后面

}

返回 $result;

}

print_r(get_filetree_scandir($path));

> Glob 函数扫描非常准确,会自动按照字母顺序排列,这似乎是最好的解决方案。

复制代码代码如下:

$path ='..';

函数 get_filetree($path){

$tree = 数组();

foreach(glob($path.'/*') as $single){

if(is_dir($single)){

$tree = array_merge($tree,get_filetree($single));

}

别的{

$tree[] = $single;

}

}

返回 $tree;

}

print_r(get_filetree($path));

【PHP遍历文件夹和子目录的函数代码】相关文章:

★ 使用 PHP 4.2 编写安全脚本

★ PHP 中如何获取文件行数

★ 完整版多文件上传系统

★ php中使用curl打开https网站

★ PHP中使用的JS打印功能

★ 用PHP创建PDF中文文档

★ 使用PHP调用数据库的存储过程

★ 使用PHP上传文件

★ 一段PHP加解密代码

★ 多文件上传示例

php抓取开奖网页内容(网站收录、快速排名、发包快排代理OEM:优采云采集网站php源码)

网站优化 • 优采云 发表了文章 • 0 个评论 • 96 次浏览 • 2021-10-04 04:01

网站收录,快速排名,快速调度代理OEM:【】

优采云采集网站php源码:有没有人参加过SEM和seo培训,价格多少?

1、一般来说,最低要求的外链专家最低分应该是20005000一个月。技能好的话,最低工资5000。这里有个问题。很多人对SEO不是很了解,但是他们在做SEO工作。如果拿不到高薪,就觉得做SEO很辛苦,没有前途。真正的大师为自己做。

优采云采集网站php源码,著名网站

2、就目前对SEO的理解,很多互联网公司还是会发链接,更新。所以如果你说去公司学习,我建议你忘记它。首先,公司不一定要做。其次,老板招聘你是为了让你为他创造利润。这不是你学习的。当然可以学,但前提是绝对的。不影响工作。

3、如果你真的有兴趣,认真学习,专心学习,不要想着去上班,如果你学得好,找到工作,公司就急着问你。

优采云采集网站php源码:如何解决网站的收录问题

网站收录这个问题一直困扰着我们,因为如果百度不收录,我们所有的工作都会白费,所以网站收录很重要那么怎样才能提高网站收录的率呢?做好以下三点,网站绝对可以快速收录。

第一:尽量增加蜘蛛访问频率网站;

第二:网站建立良好的站点结构;

第三:让蜘蛛知道我们的网站值对用户有用。

一、 增加蜘蛛访问频率 网站

网站 蜘蛛访问我们的次数越多,网站 成为 收录 的可能性就越大。我们通常的操作方式是站内站外:

站内:保持固定频率,固定更新网站的内容,但必须保证内容质量,否则适得其反。

站外:在高权重网站中,投稿增加网站的权重,吸引蜘蛛访问网站。

二、 建立良好的站点结构

仅仅吸引蜘蛛是不够的。有必要构建网站结构,让蜘蛛在网站中畅通无阻地爬行。我们可以使用面包屑导航、网站地图等来保证蜘蛛顺利抓取网站上的所有网页。

注意:不要使用 js、flash 和 iframe 框架,因为这些蜘蛛是无法识别的。

通常站点的内部结构可以是树状结构,但是小的网站最好扁平化:

①首页链接到所有频道首页

②所有频道首页都连接到其他频道首页

③频道首页总是回到网站的首页

④频道首页还链接到自己频道的内容页

⑤所有内容页面链接到网站首页

⑥所有内容页面都连接到其上级频道的首页

⑦内容页可以连接到同一频道的其他内容页

⑧内容页一般不连接其他频道的内容页

三、 让蜘蛛知道网页的价值和意义

优采云采集网站php源码,著名网站

如果想让搜索引擎对收录网站内容,首先需要证明内容的价值。

①原创度数:写作水平不是很好,可以适当伪原创,然后用原创度数检测工具检查一下。努力做好原创高内容。

②降低网站内部信息内容的重复率。

③网页字数不少于300字。当然,拥有的越多,收录的可能性就越大。

此外,站长还可以利用内页和外链来引导百度抓取内页。这个方法效果很好!

优采云采集网站php源码:想在合肥学习SEO。合肥有谁培训SEO,实力如何?

合肥这边的SEO工资不高,很正常。您可以在进行 SEO 的同时学习美术软件和一些程序。就这样,一年之内,你的知识和掌握的都全面了,然后你我再找工作,肯定5000。我相信你能做到

优采云采集网站php源码,著名网站优采云采集网站php源码:网站how打造360搜索引擎收录5

360收录网站,主要有3个步骤:

1、检查你的网站robotstxt文件是否允许360搜索蜘蛛抓取;爬取后可以直接进行第三步;

2、没有被捕获,请在你的网站代码中的robotstxt文件中添加以下代码:Useragent 360SpiderAllow /

3、登录360综合搜索并提交收录申请。等待批准。

基本流程如上。想要提高被收录的概率,需要做相应的SEO优化工作,完善自己的流程,这样被收录的概率才会高。还可以执行其他操作来增加成为收录的概率:

一是为360搜索制作友情链接,二是联系360搜索的工作人员,并给予一定的排名广告费用,三是优化关键词的内容, 网站等SEO优化工作。

只有彻底优化网站,增加网站本身的流量,收录网站对双方都是有利的。

优采云采集网站php源码,有名的网站优采云采集网站php源码:什么样的网站 易做百度收录

持续更新,坚持原创内容网站。

有一定数量的外链,以及专注于某个行业的网站。

优采云采集网站php源码,著名网站

访问通畅,速度正常网站。 查看全部

php抓取开奖网页内容(网站收录、快速排名、发包快排代理OEM:优采云采集网站php源码)

网站收录,快速排名,快速调度代理OEM:【】

优采云采集网站php源码:有没有人参加过SEM和seo培训,价格多少?

1、一般来说,最低要求的外链专家最低分应该是20005000一个月。技能好的话,最低工资5000。这里有个问题。很多人对SEO不是很了解,但是他们在做SEO工作。如果拿不到高薪,就觉得做SEO很辛苦,没有前途。真正的大师为自己做。

优采云采集网站php源码,著名网站

2、就目前对SEO的理解,很多互联网公司还是会发链接,更新。所以如果你说去公司学习,我建议你忘记它。首先,公司不一定要做。其次,老板招聘你是为了让你为他创造利润。这不是你学习的。当然可以学,但前提是绝对的。不影响工作。

3、如果你真的有兴趣,认真学习,专心学习,不要想着去上班,如果你学得好,找到工作,公司就急着问你。

优采云采集网站php源码:如何解决网站的收录问题

网站收录这个问题一直困扰着我们,因为如果百度不收录,我们所有的工作都会白费,所以网站收录很重要那么怎样才能提高网站收录的率呢?做好以下三点,网站绝对可以快速收录。

第一:尽量增加蜘蛛访问频率网站;

第二:网站建立良好的站点结构;

第三:让蜘蛛知道我们的网站值对用户有用。

一、 增加蜘蛛访问频率 网站

网站 蜘蛛访问我们的次数越多,网站 成为 收录 的可能性就越大。我们通常的操作方式是站内站外:

站内:保持固定频率,固定更新网站的内容,但必须保证内容质量,否则适得其反。

站外:在高权重网站中,投稿增加网站的权重,吸引蜘蛛访问网站。

二、 建立良好的站点结构

仅仅吸引蜘蛛是不够的。有必要构建网站结构,让蜘蛛在网站中畅通无阻地爬行。我们可以使用面包屑导航、网站地图等来保证蜘蛛顺利抓取网站上的所有网页。

注意:不要使用 js、flash 和 iframe 框架,因为这些蜘蛛是无法识别的。

通常站点的内部结构可以是树状结构,但是小的网站最好扁平化:

①首页链接到所有频道首页

②所有频道首页都连接到其他频道首页

③频道首页总是回到网站的首页

④频道首页还链接到自己频道的内容页

⑤所有内容页面链接到网站首页

⑥所有内容页面都连接到其上级频道的首页

⑦内容页可以连接到同一频道的其他内容页

⑧内容页一般不连接其他频道的内容页

三、 让蜘蛛知道网页的价值和意义

优采云采集网站php源码,著名网站

如果想让搜索引擎对收录网站内容,首先需要证明内容的价值。

①原创度数:写作水平不是很好,可以适当伪原创,然后用原创度数检测工具检查一下。努力做好原创高内容。

②降低网站内部信息内容的重复率。

③网页字数不少于300字。当然,拥有的越多,收录的可能性就越大。

此外,站长还可以利用内页和外链来引导百度抓取内页。这个方法效果很好!

优采云采集网站php源码:想在合肥学习SEO。合肥有谁培训SEO,实力如何?

合肥这边的SEO工资不高,很正常。您可以在进行 SEO 的同时学习美术软件和一些程序。就这样,一年之内,你的知识和掌握的都全面了,然后你我再找工作,肯定5000。我相信你能做到

优采云采集网站php源码,著名网站优采云采集网站php源码:网站how打造360搜索引擎收录5

360收录网站,主要有3个步骤:

1、检查你的网站robotstxt文件是否允许360搜索蜘蛛抓取;爬取后可以直接进行第三步;

2、没有被捕获,请在你的网站代码中的robotstxt文件中添加以下代码:Useragent 360SpiderAllow /

3、登录360综合搜索并提交收录申请。等待批准。

基本流程如上。想要提高被收录的概率,需要做相应的SEO优化工作,完善自己的流程,这样被收录的概率才会高。还可以执行其他操作来增加成为收录的概率:

一是为360搜索制作友情链接,二是联系360搜索的工作人员,并给予一定的排名广告费用,三是优化关键词的内容, 网站等SEO优化工作。

只有彻底优化网站,增加网站本身的流量,收录网站对双方都是有利的。

优采云采集网站php源码,有名的网站优采云采集网站php源码:什么样的网站 易做百度收录

持续更新,坚持原创内容网站。

有一定数量的外链,以及专注于某个行业的网站。

优采云采集网站php源码,著名网站

访问通畅,速度正常网站。

php抓取开奖网页内容(网页爬取代码地址:西方人口数据文本编辑程序:headers中添加hosts)

网站优化 • 优采云 发表了文章 • 0 个评论 • 93 次浏览 • 2021-10-01 10:01

php抓取开奖网页内容,用于统计数据,与此同时,可以从国家人口数据中,抓取获取人口样本。以供建模中的用于深度学习的训练和使用。1.准备工作工欲善其事必先利其器!计算网页内容已经是很容易的事情了,所以我们需要一款具有抓取功能的神器,requests库,强烈推荐!该库将会在之后的文章中不断更新!2.网页文本爬取案例网页中,内容主要有14个,要爬取2k多的数据,同时计算式较多,本文以西方的人口数据为例,有兴趣的同学请挖掘其他国家人口数据。

网页爬取代码地址:西方人口数据文本编辑程序:headers中添加hosts,具体配置如下:application/x-www-form-urlencoded";charset=utf-8">3.python代码内容整理如下:在浏览器打开此网页,双击“span”,代码提示文本为爬取不会爬取到“background-image”类型的内容,本人使用linux系统,故使用git命令,并将文本清理掉后,再编写程序:3.1打开git根据提示,爬取(网页地址,分页)background-images库。

源码如下:3.2解析上述background-image图片类型信息b=''b.replace('\t','\f')img=requests.get('',headers=headers)tx=img.replace('\t','\f')x=requests.get('',headers=headers)print('headers:',headers)print('user-agent:',user-agent)print('headers[']=',headers['])print('x[']=',x['])forxinxrange(1000。

0):img=b。contentx。extract_all()ifimginimg:print('imagenotavailable!')else:print('background-imagecopiedin'+str(x)+'!')x。extract()img=img。replace('\t','\f')x。extract()img=xrange(1000。

0)[0]x。extract()img=img。replace('\t','\f')x。extract()3。3print("爬取过程:",b)print("[",b)print("[%d%d]"%(b,x['x'],x['y']))print("[",b)print("['h']=",b)print('(',b)print(')')运行程序,全程支持网页和本地双击foriinrange(1000。

0):forjinrange(0,1000

0):print("正常爬取结果['a','c']",i)print("['a','d']",j)print("['h']=",b)print("['h','g']",x['c'],x['d'])print("['y']=",x['d'] 查看全部

php抓取开奖网页内容(网页爬取代码地址:西方人口数据文本编辑程序:headers中添加hosts)

php抓取开奖网页内容,用于统计数据,与此同时,可以从国家人口数据中,抓取获取人口样本。以供建模中的用于深度学习的训练和使用。1.准备工作工欲善其事必先利其器!计算网页内容已经是很容易的事情了,所以我们需要一款具有抓取功能的神器,requests库,强烈推荐!该库将会在之后的文章中不断更新!2.网页文本爬取案例网页中,内容主要有14个,要爬取2k多的数据,同时计算式较多,本文以西方的人口数据为例,有兴趣的同学请挖掘其他国家人口数据。

网页爬取代码地址:西方人口数据文本编辑程序:headers中添加hosts,具体配置如下:application/x-www-form-urlencoded";charset=utf-8">3.python代码内容整理如下:在浏览器打开此网页,双击“span”,代码提示文本为爬取不会爬取到“background-image”类型的内容,本人使用linux系统,故使用git命令,并将文本清理掉后,再编写程序:3.1打开git根据提示,爬取(网页地址,分页)background-images库。

源码如下:3.2解析上述background-image图片类型信息b=''b.replace('\t','\f')img=requests.get('',headers=headers)tx=img.replace('\t','\f')x=requests.get('',headers=headers)print('headers:',headers)print('user-agent:',user-agent)print('headers[']=',headers['])print('x[']=',x['])forxinxrange(1000。

0):img=b。contentx。extract_all()ifimginimg:print('imagenotavailable!')else:print('background-imagecopiedin'+str(x)+'!')x。extract()img=img。replace('\t','\f')x。extract()img=xrange(1000。

0)[0]x。extract()img=img。replace('\t','\f')x。extract()3。3print("爬取过程:",b)print("[",b)print("[%d%d]"%(b,x['x'],x['y']))print("[",b)print("['h']=",b)print('(',b)print(')')运行程序,全程支持网页和本地双击foriinrange(1000。

0):forjinrange(0,1000

0):print("正常爬取结果['a','c']",i)print("['a','d']",j)print("['h']=",b)print("['h','g']",x['c'],x['d'])print("['y']=",x['d']

php抓取开奖网页内容(php抓取开奖网页内容的程序实现只有小程序或者微信)

网站优化 • 优采云 发表了文章 • 0 个评论 • 58 次浏览 • 2021-09-21 05:03

php抓取开奖网页内容的程序实现只有小程序程序或者微信小程序可以办到,

在哪里下手抓取这些网站的信息呢?找爬虫有几种比较常见的方式

1)爬虫爬百度站长首页,百度新闻时抓取每个网站的每一个标题信息。

2)如果网站有公司网站,则进入其官网进行抓取。抓取公司网站或者其它需要抓取网页的网站。或者进入其页面模拟点击进入,进行抓取。

程序开发没有捷径,

只有百度的爬虫可以抓

爬虫不好做,高薪都要卡死。这个行业还是公司的管理层在做。

php不就是最好的。这个世界上会编程的那么多,到那时还找得到工作才不正常。

如果我跟你一样爱折腾,很自信我能够爬取到,那么现在百度还是人工爬虫。

可以搞,爬虫是一整套的东西,php只是其中的一种最基础的工具,每个公司都会有对应的技术团队,你可以关注一下他们的qq群,每年有很多大大小小的项目需要php/html/html5抓取。(我个人认为不用直接学php,因为php并不算一门好编程语言,更适合于非it专业的人学习,你可以先学习shell、linux、python。

相信我在你三天过后还是不会有啥收获,因为爬虫不是一门好编程语言)最后拿出来一份我以前的计划表来给你参考一下第一步先去招聘网站看看。php技术方面的。找到一份大概薪水范围,爬了几个公司就知道自己能够达到哪个水平,爬取到的公司要看情况。我爬取了大概30多家还算不错的公司。已经了解情况了一个星期看了十几家,基本就放弃了。所以基本不是技术问题。接下来才是你需要学习的。准备python,准备java、jsp、html。

5、xml,做完这几个准备差不多已经到你了解基本的爬虫流程了。看了上面说的,没有兴趣的话一门都不要学(语言不重要,关键是要知道爬取的知识。 查看全部

php抓取开奖网页内容(php抓取开奖网页内容的程序实现只有小程序或者微信)

php抓取开奖网页内容的程序实现只有小程序程序或者微信小程序可以办到,

在哪里下手抓取这些网站的信息呢?找爬虫有几种比较常见的方式

1)爬虫爬百度站长首页,百度新闻时抓取每个网站的每一个标题信息。

2)如果网站有公司网站,则进入其官网进行抓取。抓取公司网站或者其它需要抓取网页的网站。或者进入其页面模拟点击进入,进行抓取。

程序开发没有捷径,

只有百度的爬虫可以抓

爬虫不好做,高薪都要卡死。这个行业还是公司的管理层在做。

php不就是最好的。这个世界上会编程的那么多,到那时还找得到工作才不正常。

如果我跟你一样爱折腾,很自信我能够爬取到,那么现在百度还是人工爬虫。

可以搞,爬虫是一整套的东西,php只是其中的一种最基础的工具,每个公司都会有对应的技术团队,你可以关注一下他们的qq群,每年有很多大大小小的项目需要php/html/html5抓取。(我个人认为不用直接学php,因为php并不算一门好编程语言,更适合于非it专业的人学习,你可以先学习shell、linux、python。

相信我在你三天过后还是不会有啥收获,因为爬虫不是一门好编程语言)最后拿出来一份我以前的计划表来给你参考一下第一步先去招聘网站看看。php技术方面的。找到一份大概薪水范围,爬了几个公司就知道自己能够达到哪个水平,爬取到的公司要看情况。我爬取了大概30多家还算不错的公司。已经了解情况了一个星期看了十几家,基本就放弃了。所以基本不是技术问题。接下来才是你需要学习的。准备python,准备java、jsp、html。

5、xml,做完这几个准备差不多已经到你了解基本的爬虫流程了。看了上面说的,没有兴趣的话一门都不要学(语言不重要,关键是要知道爬取的知识。

php抓取开奖网页内容(php抓取开奖网页内容分析不易,实际下来都是excel格式,转化好麻烦)

网站优化 • 优采云 发表了文章 • 0 个评论 • 62 次浏览 • 2021-09-17 16:09

php抓取开奖网页内容分析不易,实际下来都是excel格式,转化好麻烦。本文通过已知的几个网站(百度,gogod),抓取开奖日期的下面几个表格。page1[ls]share:=[][dp]all:=[][ad][buy][c:h#][form][ssr:hs:hf:uf:bs:bls:bm]check_all:=[][dp]b1:=[][dp]b2:=[][dp]b3:=[][dp]b4:=[][dp]b5:=[][dp]b6:=[][dp]b7:=[][dp]b8:=[][dp]b9:=[][dp]b10:=[][dp]b11:=[][dp]b12:=[][dp]b13:=[][dp]b14:=[][dp][page][mc][wh]=[][mp]page5[ls]share:=[][dp]share:=[][dp]share:=[][dp]share:=[][dp]share:=[][dp]share:=[][dp]share:=[][dp]share:=[][dp]share:=[][dp]share:=[][dp]share:=[][dp]抓取开奖网站开奖号码表,进行vba获取开奖时间,再抓取开奖结果表,并结合数据透视表展示。

可以这样。 查看全部

php抓取开奖网页内容(php抓取开奖网页内容分析不易,实际下来都是excel格式,转化好麻烦)

php抓取开奖网页内容分析不易,实际下来都是excel格式,转化好麻烦。本文通过已知的几个网站(百度,gogod),抓取开奖日期的下面几个表格。page1[ls]share:=[][dp]all:=[][ad][buy][c:h#][form][ssr:hs:hf:uf:bs:bls:bm]check_all:=[][dp]b1:=[][dp]b2:=[][dp]b3:=[][dp]b4:=[][dp]b5:=[][dp]b6:=[][dp]b7:=[][dp]b8:=[][dp]b9:=[][dp]b10:=[][dp]b11:=[][dp]b12:=[][dp]b13:=[][dp]b14:=[][dp][page][mc][wh]=[][mp]page5[ls]share:=[][dp]share:=[][dp]share:=[][dp]share:=[][dp]share:=[][dp]share:=[][dp]share:=[][dp]share:=[][dp]share:=[][dp]share:=[][dp]share:=[][dp]抓取开奖网站开奖号码表,进行vba获取开奖时间,再抓取开奖结果表,并结合数据透视表展示。

可以这样。

php抓取开奖网页内容(抓取网页数据都是用Java抓更方便(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 89 次浏览 • 2021-09-13 04:03

阿里云>云栖社区>主题图>J>js抓取标签内容

推荐活动:

更多优惠>

当前主题:js抓取标签的内容并添加到集合中

相关主题:

js抓取与标签内容相关的博客,查看更多博客

[Web Crawler] 使用 node.js cheerio 抓取网页数据

作者:子瑜 5358 次浏览和评论:05 年前

您是想自动从网页中抓取一些数据,还是想将从哪个博客中提取的数据转换为结构化数据?有没有现成的API来获取数据? ! ! ! !@#$@#$... 没关系。网络爬虫可以解决。什么是网络爬虫?你可能会问。 . 网络爬虫就是以编程方式(通常无需浏览器参与)检索网页内容

阅读全文

PHP 使用 QueryList 抓取网页内容

作者:Jack Chen 1527 次浏览和评论:06 年前

原文:PHP在使用Java Jsoup抓取网页数据之前,先使用QueryList抓取网页内容。前几天听说用PHP抓起来比较方便。今天研究了一下,主要是用QueryList来实现。 QueryList是一个基于phpQuery的通用列表采集类,简单灵活,功能强大

阅读全文

PHP 使用 QueryList 抓取网页内容

作者:thinkyoung1544 人浏览评论:06 年前

我之前用Java Jsoup抓取网页数据。前几天听说用PHP抓包比较方便。今天简单研究了一下,主要是使用QueryList。 QueryList 基于 phpQ

阅读全文

C#抓取AJAX页面内容

作者:Jack Chen,627 次浏览和评论:07 年前

C#原创 抓取AJAX页面的内容 目前网页有相当一部分使用了AJAX技术。所谓的AJAX技术就是简单的事件驱动(当然这个说法可能很不完整),在你提交了URL之后,服务器发给你的并不是所有的页面内容,而是很大一部分是JS脚本,准备使用

阅读全文

使用 JS 和 NodeJS 抓取网页内容

作者:云启豪资讯小哥1002人浏览评论:01年前

云启豪资讯:【点击查看更多行业资讯】在这里你可以找到不同行业的一手云资讯,还等什么,快来吧!先决条件 这个文章主要面向有一定Javascript开发经验的开发者。但如果您熟悉网页内容抓取,即使您没有 Javascript 相关经验,

阅读全文

Baidu网站Optimization:如何增加蜘蛛爬行?

作者:蝙蝠侠 it1205 浏览评论人数:02年前

在SEO工作中,适当增加百度蜘蛛对网站的抓取,有助于增加网站内容的收录量,从而进一步提升排名。这是每个网站运营经理都必须思考的问题。那么,在增加网站百度蜘蛛的抓取量之前,我们必须考虑的问题之一就是提高网站的打开速度。百度网站Optimization:如何增加蜘蛛爬行量

阅读全文

Google 抓取工具如何抓取 JavaScript?

作者:邢哲武松1992年浏览评论人数:04年前

我们测试了 Google 爬虫是如何抓取 JavaScript 的,以下是我们从中学到的东西。认为 Google 无法处理 JavaScript?再想想。 Audette Audette 分享了一系列测试结果。他和他的同事测试了哪些类型的 JavaScript 函数会受到影响

阅读全文

使用 Scrapy 抓取数据

作者:于客 6542人浏览评论:05年前

Scrapy 是一个由 Python 开发的快速、高级的屏幕抓取和网页抓取框架,用于抓取网站和从页面中提取结构化数据。 Scrapy 用途广泛,可用于数据挖掘、监控和自动化测试。官方主页:中文文档:Scrap

阅读全文

js抓取标签内容相关问题

【javascript学习全家桶】934道javascript热点问题,百位阿里巴巴技术专家解答

作者:管理贝贝 5207人浏览评论:13年前

阿里极客公益活动:也许你在为一个问题在夜里打灯,也许你困惑只是在寻求答案,也许你因为一个未知而绞尽脑汁,那么他们来了,阿里巴巴技术专家来云栖为您答疑解惑技术问题是用户自己的技术,帮助用户成长。本次活动邀请数百位阿里技术

阅读全文 查看全部

php抓取开奖网页内容(抓取网页数据都是用Java抓更方便(组图))

阿里云>云栖社区>主题图>J>js抓取标签内容

推荐活动:

更多优惠>

当前主题:js抓取标签的内容并添加到集合中

相关主题:

js抓取与标签内容相关的博客,查看更多博客

[Web Crawler] 使用 node.js cheerio 抓取网页数据

作者:子瑜 5358 次浏览和评论:05 年前

您是想自动从网页中抓取一些数据,还是想将从哪个博客中提取的数据转换为结构化数据?有没有现成的API来获取数据? ! ! ! !@#$@#$... 没关系。网络爬虫可以解决。什么是网络爬虫?你可能会问。 . 网络爬虫就是以编程方式(通常无需浏览器参与)检索网页内容

阅读全文

PHP 使用 QueryList 抓取网页内容

作者:Jack Chen 1527 次浏览和评论:06 年前

原文:PHP在使用Java Jsoup抓取网页数据之前,先使用QueryList抓取网页内容。前几天听说用PHP抓起来比较方便。今天研究了一下,主要是用QueryList来实现。 QueryList是一个基于phpQuery的通用列表采集类,简单灵活,功能强大

阅读全文

PHP 使用 QueryList 抓取网页内容

作者:thinkyoung1544 人浏览评论:06 年前

我之前用Java Jsoup抓取网页数据。前几天听说用PHP抓包比较方便。今天简单研究了一下,主要是使用QueryList。 QueryList 基于 phpQ

阅读全文

C#抓取AJAX页面内容

作者:Jack Chen,627 次浏览和评论:07 年前

C#原创 抓取AJAX页面的内容 目前网页有相当一部分使用了AJAX技术。所谓的AJAX技术就是简单的事件驱动(当然这个说法可能很不完整),在你提交了URL之后,服务器发给你的并不是所有的页面内容,而是很大一部分是JS脚本,准备使用

阅读全文

使用 JS 和 NodeJS 抓取网页内容

作者:云启豪资讯小哥1002人浏览评论:01年前

云启豪资讯:【点击查看更多行业资讯】在这里你可以找到不同行业的一手云资讯,还等什么,快来吧!先决条件 这个文章主要面向有一定Javascript开发经验的开发者。但如果您熟悉网页内容抓取,即使您没有 Javascript 相关经验,

阅读全文

Baidu网站Optimization:如何增加蜘蛛爬行?

作者:蝙蝠侠 it1205 浏览评论人数:02年前

在SEO工作中,适当增加百度蜘蛛对网站的抓取,有助于增加网站内容的收录量,从而进一步提升排名。这是每个网站运营经理都必须思考的问题。那么,在增加网站百度蜘蛛的抓取量之前,我们必须考虑的问题之一就是提高网站的打开速度。百度网站Optimization:如何增加蜘蛛爬行量

阅读全文

Google 抓取工具如何抓取 JavaScript?

作者:邢哲武松1992年浏览评论人数:04年前

我们测试了 Google 爬虫是如何抓取 JavaScript 的,以下是我们从中学到的东西。认为 Google 无法处理 JavaScript?再想想。 Audette Audette 分享了一系列测试结果。他和他的同事测试了哪些类型的 JavaScript 函数会受到影响

阅读全文

使用 Scrapy 抓取数据

作者:于客 6542人浏览评论:05年前

Scrapy 是一个由 Python 开发的快速、高级的屏幕抓取和网页抓取框架,用于抓取网站和从页面中提取结构化数据。 Scrapy 用途广泛,可用于数据挖掘、监控和自动化测试。官方主页:中文文档:Scrap

阅读全文

js抓取标签内容相关问题

【javascript学习全家桶】934道javascript热点问题,百位阿里巴巴技术专家解答

作者:管理贝贝 5207人浏览评论:13年前

阿里极客公益活动:也许你在为一个问题在夜里打灯,也许你困惑只是在寻求答案,也许你因为一个未知而绞尽脑汁,那么他们来了,阿里巴巴技术专家来云栖为您答疑解惑技术问题是用户自己的技术,帮助用户成长。本次活动邀请数百位阿里技术

阅读全文

php抓取开奖网页内容(前两天想写一段自动提取微博状态的代码布布扣,)

网站优化 • 优采云 发表了文章 • 0 个评论 • 87 次浏览 • 2021-09-13 04:00

我想写一个代码,自动提取前两天微博状态。据我所知,这个函数可以用 PHP 或 Java 编写。我觉得用Java写调试比较方便,需要上传PHP脚本到服务器什么的。

代码很简单,新建一个包URL类对象,使用这个url作为写入源,将内容存放在一个字符串中。然后创建一个新文件并写出字符串。但是请注意,不同的网站 使用不同的编码字。现在大多数网站 使用utf-8 字符编码,而建立在wordpress 上的网站 使用这种编码字符。但是很多中文网站,包括网易等门户网站,仍然使用gb2312编码。一方面,gb2312的历史比utf-8还要长。早期的中文网站是用gb2312构建的,现在修改工作量太大;另一方面,要显示相同长度的文本内容,使用gb2312编码比utf-8编码时节省空间。由于这种差异,您在输入网页的html代码时应该选择正确的阅读方式。 java输入流构造函数可以选择utf-8作为参数,但是没有gb2312选项。因此,在抓取网易网页时,保存的文档中会出现乱码。

另外,这个例子只是抓取静态网页内容,对于微博的状态还是不太好,因为要抓取状态,必须先登录账号,所以需要参考新浪的API文档.

import java.beans.FeatureDescriptor;

import java.io.*;

import java.net.*;

public class spider {

/**

* @param args

*/

public static String fetchWebpage(String urlname){

URL url;

String s;

StringBuffer sbuffer = new StringBuffer();

try{

url = new URL(urlname);

// my website use utf-8, but some other websites, like 163 and baidu, use gb2312.

InputStreamReader sreader = new InputStreamReader(url.openStream(),"utf-8");

BufferedReader breader = new BufferedReader(sreader);

while((s=breader.readLine())!=null){

sbuffer.append(s);

}

breader.close();

}catch(Exception e){

e.printStackTrace();

}

return sbuffer.toString();

}

public static void main(String[] args) throws IOException {

// TODO Auto-generated method stub

String address = "http://www.mr-naive.com";

FileOutputStream fos = new FileOutputStream(new File("myPage.html"));

OutputStreamWriter oswrite = new OutputStreamWriter(fos, "utf-8");

BufferedWriter bwriter = new BufferedWriter(oswrite);

bwriter.write(fetchWebpage(address));

bwriter.close();

}

}

Java抓取网页内容,布按钮,

Java 抓取网页内容

原文: 查看全部

php抓取开奖网页内容(前两天想写一段自动提取微博状态的代码布布扣,)

我想写一个代码,自动提取前两天微博状态。据我所知,这个函数可以用 PHP 或 Java 编写。我觉得用Java写调试比较方便,需要上传PHP脚本到服务器什么的。

代码很简单,新建一个包URL类对象,使用这个url作为写入源,将内容存放在一个字符串中。然后创建一个新文件并写出字符串。但是请注意,不同的网站 使用不同的编码字。现在大多数网站 使用utf-8 字符编码,而建立在wordpress 上的网站 使用这种编码字符。但是很多中文网站,包括网易等门户网站,仍然使用gb2312编码。一方面,gb2312的历史比utf-8还要长。早期的中文网站是用gb2312构建的,现在修改工作量太大;另一方面,要显示相同长度的文本内容,使用gb2312编码比utf-8编码时节省空间。由于这种差异,您在输入网页的html代码时应该选择正确的阅读方式。 java输入流构造函数可以选择utf-8作为参数,但是没有gb2312选项。因此,在抓取网易网页时,保存的文档中会出现乱码。

另外,这个例子只是抓取静态网页内容,对于微博的状态还是不太好,因为要抓取状态,必须先登录账号,所以需要参考新浪的API文档.

import java.beans.FeatureDescriptor;

import java.io.*;

import java.net.*;

public class spider {

/**

* @param args

*/

public static String fetchWebpage(String urlname){

URL url;

String s;

StringBuffer sbuffer = new StringBuffer();

try{

url = new URL(urlname);

// my website use utf-8, but some other websites, like 163 and baidu, use gb2312.

InputStreamReader sreader = new InputStreamReader(url.openStream(),"utf-8");

BufferedReader breader = new BufferedReader(sreader);

while((s=breader.readLine())!=null){

sbuffer.append(s);

}

breader.close();

}catch(Exception e){

e.printStackTrace();

}

return sbuffer.toString();

}

public static void main(String[] args) throws IOException {

// TODO Auto-generated method stub

String address = "http://www.mr-naive.com";

FileOutputStream fos = new FileOutputStream(new File("myPage.html"));

OutputStreamWriter oswrite = new OutputStreamWriter(fos, "utf-8");

BufferedWriter bwriter = new BufferedWriter(oswrite);

bwriter.write(fetchWebpage(address));

bwriter.close();

}

}

Java抓取网页内容,布按钮,

Java 抓取网页内容

原文:

php抓取开奖网页内容(php抓取开奖网页内容一般是使用php的websocket程序内容)

网站优化 • 优采云 发表了文章 • 0 个评论 • 100 次浏览 • 2021-09-10 05:00

php抓取开奖网页内容一般是使用php的websocket程序,同一网站同一版本都可以提供这种接口,一般是每隔5分钟更新一次开奖号码。不同版本的接口是不通用的,相应的测试cookie也是有变化的,服务器端可以直接存一份,php可以直接读取存储的cookie文件。(程序员真的牛逼,楼主自行更换google搜索websocketdemo)。

具体问题具体分析。你要给出这台电脑的ip以及电脑上php的版本和位置。

小白一个,没研究过。统计用的数据库,一般在oracle上比较多。

想说,说说就好,别介意。不知道你要问的是什么?可以告诉我一下。

希望不要加入php语言方面的限制,推荐laravel+loader来做。

技术无价,

node.js不行吗?

你是指抓包抓哪种数据?一般问技术,都会说抓取网页数据吧,那当然是使用javascript/css3/html/httpserver发送请求数据,这种情况,不需要抓包(还可以用可视化工具抓、可以做伪持久化存储),直接找对应的浏览器抓就好了。不过你这么问可能意思是你自己的网站数据抓不到吧,还是用可视化工具抓。如果是服务器抓取的话,你不了解的话,就用php5的loader抓stringreader吧。

javascriptphp都能抓,前端的话php5.6也可以,目前技术没啥问题。 查看全部

php抓取开奖网页内容(php抓取开奖网页内容一般是使用php的websocket程序内容)

php抓取开奖网页内容一般是使用php的websocket程序,同一网站同一版本都可以提供这种接口,一般是每隔5分钟更新一次开奖号码。不同版本的接口是不通用的,相应的测试cookie也是有变化的,服务器端可以直接存一份,php可以直接读取存储的cookie文件。(程序员真的牛逼,楼主自行更换google搜索websocketdemo)。

具体问题具体分析。你要给出这台电脑的ip以及电脑上php的版本和位置。

小白一个,没研究过。统计用的数据库,一般在oracle上比较多。

想说,说说就好,别介意。不知道你要问的是什么?可以告诉我一下。

希望不要加入php语言方面的限制,推荐laravel+loader来做。

技术无价,

node.js不行吗?

你是指抓包抓哪种数据?一般问技术,都会说抓取网页数据吧,那当然是使用javascript/css3/html/httpserver发送请求数据,这种情况,不需要抓包(还可以用可视化工具抓、可以做伪持久化存储),直接找对应的浏览器抓就好了。不过你这么问可能意思是你自己的网站数据抓不到吧,还是用可视化工具抓。如果是服务器抓取的话,你不了解的话,就用php5的loader抓stringreader吧。

javascriptphp都能抓,前端的话php5.6也可以,目前技术没啥问题。