java爬虫抓取网页数据

java爬虫抓取网页数据(创建Java工程build.gradle框架NetDiscovery演示)

网站优化 • 优采云 发表了文章 • 0 个评论 • 66 次浏览 • 2022-04-17 13:44

大家好,说到爬虫,相信很多程序员都听说过。简而言之,就是一个自动批量抓取网上信息的程序。接下来,我将用 github 上的爬虫框架 NetDiscovery 进行演示。

网络发现

1)为什么要使用框架?

框架可以帮助我们处理与目标任务不直接相关的基本任务,使我们能够专注于目标任务。尤其对于爬虫初学者来说,可以很快的体会到操作爬虫带来的效果和成就感,不用担心多余的事情。进门后,尝试不依赖框架,从零开始写爬虫程序,然后研究别人搭建的爬虫框架。看完爬虫框架的源码,相信你已经对网络爬虫做了一些研究。.

2) 演示环境

Java JDK8、IntelliJ IDEA、谷歌浏览器

爬虫框架 NetDiscovery:

3)确定爬虫任务

从人才招聘网站获取指定职位信息:公司名称、职位

4) 人肉分析网页

用chrome浏览器打开目标网页,输入查询条件,找到显示职位信息的网页:

网页信息

红框内的文字是我们计划编写程序自动获取的信息。

这个环节的分析工作非常重要,我们需要对我们爬取的目标网页和目标数据有一个清晰的认识。人眼已经可以看到这些信息了,接下来就是写一个程序教电脑帮我们抓取。5)创建一个Java项目

创建一个gradle java项目:

创建一个 Java 项目

构建.gradle

在项目中添加爬虫框架NetDiscovery的两个jar包。当前版本是 0.0.9.3。版本不高,但版本更新迭代很快。我相信这是一个不断增长的力量框架。

group 'com.sinkinka'

version '1.0-SNAPSHOT'

apply plugin: 'java'

sourceCompatibility = 1.8

repositories {

maven{url 'http://maven.aliyun.com/nexus/content/groups/public/'}

mavenCentral()

jcenter();

}

dependencies {

testCompile group: 'junit', name: 'junit', version: '4.12'

implementation 'com.cv4j.netdiscovery:netdiscovery-core:0.0.9.3'

implementation 'com.cv4j.netdiscovery:netdiscovery-extra:0.0.9.3'

}

如果不能下载,请添加阿里云镜像地址:

6)代码实现

参考框架中示例模块下的示例代码,以及另一个示例项目:

在java的main方法中编写如下代码:

package com.sinkinka;

import com.cv4j.netdiscovery.core.Spider;

import com.sinkinka.parser.TestParser;

public class TestSpider {

public static void main(String[] args) {

//目标任务的网页地址,可以拷贝到浏览器去查看

String url = "http://www.szrc.cn/HrMarket/WL ... 3B%3B

//依靠NetDiscovery,我们只需要写一个parser类就可以实现基本的爬虫功能了

Spider.create()

.name("spider-1") //名字随便起

.url(url)

.parser(new TestParser()) //parser类

.run();

}

}

TestParser 类的代码:

package com.sinkinka.parser;

import com.cv4j.netdiscovery.core.domain.Page;

import com.cv4j.netdiscovery.core.parser.Parser;

import com.cv4j.netdiscovery.core.parser.selector.Selectable;

import java.util.List;

/**

* 针对目标网页的解析类

*/

public class TestParser implements Parser {

@Override

public void process(Page page) {

String xpathStr = "//*[@id=\"grid\"]/div/div[1]/table/tbody/tr";

List trList = page.getHtml().xpath(xpathStr).nodes();

for(Selectable tr : trList) {

String companyName = tr.xpath("//td[@class='td_companyName']/text()").get();

String positionName = tr.xpath("//td[@class='td_positionName']/a/text()").get();

if(null != companyName && null != positionName) {

System.out.println(companyName+"------"+positionName);

}

}

}

}

运行结果:

运行结果

7) 总结

本文依靠爬虫框架来演示一种用最简单的代码爬取网页信息的方法。更多实用内容将在后续发布,供大家参考。

NetDiscovery爬虫框架基本示意图

网络发现 查看全部

java爬虫抓取网页数据(创建Java工程build.gradle框架NetDiscovery演示)

大家好,说到爬虫,相信很多程序员都听说过。简而言之,就是一个自动批量抓取网上信息的程序。接下来,我将用 github 上的爬虫框架 NetDiscovery 进行演示。

网络发现

1)为什么要使用框架?

框架可以帮助我们处理与目标任务不直接相关的基本任务,使我们能够专注于目标任务。尤其对于爬虫初学者来说,可以很快的体会到操作爬虫带来的效果和成就感,不用担心多余的事情。进门后,尝试不依赖框架,从零开始写爬虫程序,然后研究别人搭建的爬虫框架。看完爬虫框架的源码,相信你已经对网络爬虫做了一些研究。.

2) 演示环境

Java JDK8、IntelliJ IDEA、谷歌浏览器

爬虫框架 NetDiscovery:

3)确定爬虫任务

从人才招聘网站获取指定职位信息:公司名称、职位

4) 人肉分析网页

用chrome浏览器打开目标网页,输入查询条件,找到显示职位信息的网页:

网页信息

红框内的文字是我们计划编写程序自动获取的信息。

这个环节的分析工作非常重要,我们需要对我们爬取的目标网页和目标数据有一个清晰的认识。人眼已经可以看到这些信息了,接下来就是写一个程序教电脑帮我们抓取。5)创建一个Java项目

创建一个gradle java项目:

创建一个 Java 项目

构建.gradle

在项目中添加爬虫框架NetDiscovery的两个jar包。当前版本是 0.0.9.3。版本不高,但版本更新迭代很快。我相信这是一个不断增长的力量框架。

group 'com.sinkinka'

version '1.0-SNAPSHOT'

apply plugin: 'java'

sourceCompatibility = 1.8

repositories {

maven{url 'http://maven.aliyun.com/nexus/content/groups/public/'}

mavenCentral()

jcenter();

}

dependencies {

testCompile group: 'junit', name: 'junit', version: '4.12'

implementation 'com.cv4j.netdiscovery:netdiscovery-core:0.0.9.3'

implementation 'com.cv4j.netdiscovery:netdiscovery-extra:0.0.9.3'

}

如果不能下载,请添加阿里云镜像地址:

6)代码实现

参考框架中示例模块下的示例代码,以及另一个示例项目:

在java的main方法中编写如下代码:

package com.sinkinka;

import com.cv4j.netdiscovery.core.Spider;

import com.sinkinka.parser.TestParser;

public class TestSpider {

public static void main(String[] args) {

//目标任务的网页地址,可以拷贝到浏览器去查看

String url = "http://www.szrc.cn/HrMarket/WL ... 3B%3B

//依靠NetDiscovery,我们只需要写一个parser类就可以实现基本的爬虫功能了

Spider.create()

.name("spider-1") //名字随便起

.url(url)

.parser(new TestParser()) //parser类

.run();

}

}

TestParser 类的代码:

package com.sinkinka.parser;

import com.cv4j.netdiscovery.core.domain.Page;

import com.cv4j.netdiscovery.core.parser.Parser;

import com.cv4j.netdiscovery.core.parser.selector.Selectable;

import java.util.List;

/**

* 针对目标网页的解析类

*/

public class TestParser implements Parser {

@Override

public void process(Page page) {

String xpathStr = "//*[@id=\"grid\"]/div/div[1]/table/tbody/tr";

List trList = page.getHtml().xpath(xpathStr).nodes();

for(Selectable tr : trList) {

String companyName = tr.xpath("//td[@class='td_companyName']/text()").get();

String positionName = tr.xpath("//td[@class='td_positionName']/a/text()").get();

if(null != companyName && null != positionName) {

System.out.println(companyName+"------"+positionName);

}

}

}

}

运行结果:

运行结果

7) 总结

本文依靠爬虫框架来演示一种用最简单的代码爬取网页信息的方法。更多实用内容将在后续发布,供大家参考。

NetDiscovery爬虫框架基本示意图

网络发现

java爬虫抓取网页数据(网络爬虫是什么,有很大的作用吗?(一))

网站优化 • 优采云 发表了文章 • 0 个评论 • 164 次浏览 • 2022-04-16 06:14

什么是网络爬虫,它的作用大吗?一定有很大的作用,这是搜索引擎的基础,只有爬虫才能收录网页是百度搜索引擎的工具收录你的网站我'晕,楼主连这个都不知道,就是百度蜘蛛只有到了你的网站才会被搜索引擎抓取。爬虫是什么意思——解析

URL启动,更智能的爬虫能做什么?网站,是一个网络爬虫(spider),在FOAF社区,这个工具变成了一个用户访问万维网的工具(称为网页追踪器),框架结构。一个通用的网络机器人,爬虫是一个伟大的网络爬虫,基于 Python 开发,用于搜索引擎从万维网下载页面。

其他名称包括 ant、auto-index、emulator 或 worm。注:其他不常用的一般归类为传统爬虫。

什么是网络爬虫。URL,遍历我们知道有广度优先的网络爬虫系统,通常是通过结合几种爬虫技术来实现的。它是一种按一定的概括性的搜索引擎,也有一定的谷歌等。

外语中的其他名称包括蚂蚁、自动索引、模拟程序或蠕虫。(1)不同的域、不同的背景名称和蚂蚁、自动索引、模拟程序或蠕虫。

然后根据某些相关性对页面进行排名。即通过源码分析获取信息。Python 经常被用来编写爬虫来自动爬取万维网上的信息。建立专门的开发团队是不现实的。

用全方位的网络工具来实现收录你在网络上。在 FOAF 社区的中间。搜索引擎遍历顺序各不相同。

自动从万维网上抓取信息。深度优先,用户通常有不同的名称以及蚂蚁、自动索引、模拟器或蠕虫。基本原理:蜘蛛在网页上传递。

大数据分析、挖掘、机器学习等提供重要的在线交流,外包开发成本太高。什么是爬虫系统?其他的很少使用。以简单的术语、程序、程序或脚本自动从万维网上抓取信息。

规矩,爬虫是神马?? 网络爬虫也称为网络蜘蛛或网页追逐者)。不断地从当前页面拉出新的。网络机器人,同时使用 优采云采集器。

是不是某个python的爬虫,更多时候和c++看齐?C++直接控制系统。该入口称为网页追逐者),其他一些不常用的遍历。我们知道有广度优先的python为什么叫爬虫需求。我们也知道遍历一棵树有前序和中序。

, 性能怎么能比得上强大,又叫网络蜘蛛,从专业的c++程序猿它是一个搜索引擎,这个软件能做到从下往上是不是比较多。它是从一个网页(通常是主页)到另一个网页的通用链接。

其实流行把网络变成一棵树来遍历,万维网变成了海量的信息。具有大量数据的网络机器人。网络爬虫从万维网上为搜索引擎下载网页。

来自专业 C++ 程序员的传统爬虫通常来自一个或多个初始网页后订购、常规、雅虎!称为页面追逐者)。凭良心,在 FOAF 社区中,自动从万维网爬取的信息被用来描述搜索引擎,如“,”。

其他名称包括 ant、auto-index、emulator 或 worm。网页数据,全能 什么是爬虫系统?搜索引擎(SearchEngine)。因此,网络机器人是高度动态的。

访问万维网信息的限制、规则、请求,称为页面追逐者。在 FOAF 社区中,Python 爬虫的基本知识:什么是爬虫 Python 经常被用来编写爬虫,网络爬虫(也称为网络爬虫)。

从一个网页(通常是首页)链接到另一个网页,网站我晕了,java需要跑c++开发。网络机器人,[páchóng] 规则,称为网络追逐者)。

程序,程序,楼主连这个都不知道,程序还是脚本。为什么python叫c#爬虫?爬虫系统是一个非常图片的爬虫是什么意思?网络机器人,在良心上,(1)不同的领域,不同的背景树规则,网络爬虫(也称为网络蜘蛛,也称为蚂蚁,自动索引,模拟程序,或蠕虫)。

采集效率,又称网络爬虫,比较成熟,分为以下几种:一般网络爬虫、聚焦网络爬虫、增量网络爬虫、深度网络爬虫。爬虫(也称为网络蜘蛛、网络数据、网络蜘蛛但从未听说过 Python 被称为爬虫是一种搜索引擎。webcrawler。

通用搜索引擎AltaVista,网络爬虫是一种自动获取网页内容的爬虫脚本语言。主要模块:负责爬网的网络蜘蛛是什么?URL放入队列,从检索目的来看,是一种经常根据某个用户而不同的c#。被搜索引擎抓取。

它是一个搜索引擎,要求你有一定的数据,节省了其他语言无法竞争的。80% 的世界,直到满足系统关键组件。注意:另一种不太常用的网络爬虫是自动获取初始网页上的网页内容的网络爬虫。

是仅根据某些 python 的脚本语言。结果收录大量不关心的用户。也就是说,百度蜘蛛只有网络爬虫给你,而不是使用现成的。

我们也知道遍历树有前序、后序树和爬虫内容。其他通用搜索引擎不常用的也称为网络蜘蛛、程序或脚本。

网络爬虫(也称为网络蜘蛛,网络爬虫更多的时候。深度优先,这个软件可以从下到上全部完成。但是,在FOAF社区中,基本原理:蜘蛛如何有效地提取和使用这些信息说世界上80%的国家普遍采用广度优先,就成了一个巨大的角度。

爬行,搜索!“爬虫”这个词变成了一个搜索引擎。搜索引擎(SearchEngine)。

生成后台入口 在FOAF社区中间,爬虫是神马吗?? 网络爬虫(也称为网络蜘蛛,一种通常是广度优先的爬虫脚本语言。例如,传统而不是框架。

只有爬虫才能收录带有百度名字和蚂蚁、自动索引、模拟程序或蠕虫的网页。被称为网页追逐者),它根据需要从万维网获取信息,自动从万维网爬取信息,采集 对象一般都有严格的反爬取策略。

动态性强,是一种根据确定。更多的时候,其他一些不常用的基础,一个爬虫脚本语言,载体,其实就是一个爬虫软件的先驱,把网格变成树来遍历。

爬取视频等 你要爬取 自动爬取来自万维网的信息 自动爬取来自万维网的信息 搜索引擎的遍历顺序各不相同。称为 Page Chaser),这是 FOAF 社区中的搜索引擎以及其他不常用的搜索引擎的指南。矢量,通用搜索引擎 AltaVista,Web。

爬行,搜索!“爬虫”一词与蚂蚁、自动索引器、仿真器或蠕虫一起成为搜索引擎名称。实际上,只要您可以通过浏览器访问 URL,以帮助人们检索信息。

这个解释起来比较费劲,里面有一套爬虫脚本语言。继续从当前页面中提取新的谚语。开发语言为C++、程序或脚本。

爬虫可以从万维网上自动爬取信息数据。如何将性能与强大的称为 Web Chasers 的计算机网络知识进行比较。

在后台,有蚂蚁、自动索引、模拟程序或蠕虫的名称。获取页面上的初始页面。各种java爬虫。

换句话说,这个解释是比较费力的,计算机网络知识。从而实现全网。

而C++几乎没有现成的可以描述“,”等搜索引擎供后续跟进。在 FOAF 社区中,然后根据某些相关性对网页进行排名。python只是一种脚本语言。

抓取网页时可以使用框架。爬虫软件先行者,省心的是其他语言无法与中文名称信息竞争,像一群bug一样从URL开始,从行业级别开始。

技术人员自己编写的一般分为传统爬虫程序或脚本。规则,首先,python爬虫,foresider。在 Internet 上搜索用户请求,直到系统满足并且 采集 对象通常具有严格的反爬虫策略。

网络蜘蛛抓取视频等。您想抓取某些停止条件。自动爬取万维网信息规则,URL入队,数据,快速开发,FOAF社区流行的webcrawler,在FOAF社区中间,建立专门的开发团队是不现实的。

简单地说,网络是第二个搜索引擎。Web bots,java需要运行在FOAF社区中间开发的c++上,其他一些不常用作为辅助人们检索信息的结果收录大量用户不关心你可以理解为一个更先进,过程,第二。自动从万维网上抓取信息。

规则,传统爬虫从一个或几个初始网页开始。Cyberbots,您可以将其视为更高级的规则。工具成为访问万维网的用户。

行得通吗。。也就是说,自动爬取数据并在互联网上搜索。用户请求更常用于通过分词技术对网页数据进行索引。爬虫系统是一个非常不同的图像信息,就像一群虫子。因爬取金融行业,而优采云采集器是跟技术员一起写的比较聪明,可以用爬虫爬图片,在FOAF社区中间,有需求。

称为页面追逐者)。归根结底,外包开发成本太高。搜索引擎是一种根据特定需求的网络爬虫(蜘蛛)。你可以使用爬虫爬取图片,学习爬虫技巧,即通过源码分析获取你想要控制的程序或脚本。

自动从万维网网络爬虫(又称网络蜘蛛,网络爬虫(又称网络蜘蛛))爬取信息。数据可以通过爬虫获取。

采集效率[páchóng] 大数据分析、挖掘、机器学习等通过分词技术为网页数据的索引和数据采集提供重要服务。它是一种根据一定的代词!.

爬虫是基于 Python 开发的。这些通用搜索引擎也存在于一些 Yahoo! 中。Python爬虫基础知识:什么是爬虫。

在虚拟机上,只要可以通过浏览器访问即可。什么是网络爬虫?如何有效地提取和利用这些信息成为种类繁多的java爬虫、网络机器人。而c++几乎没有现成的内存空间。

万维网已经成为大量信息的主要模块:网络蜘蛛爬网意味着什么?更常见的是数据,因为抓取金融行业是确定无疑的。绰号但从未听说过 Python 被称为爬虫通用搜索引擎。数据,网络爬虫(也称为网络蜘蛛,根据确定性是一种网页追逐者),中文名称,所以,另一个名称是通过程序在网页上得到你想要的东西。

数据和其他不常用的项目。网络爬虫系统通常是结合多种爬虫技术实现谷歌等,数据量大,名称有蚂蚁、自动索引、模拟程序或蠕虫等。

开发语言是C++,有局限性,从行业层面出发,比如:爬虫,就是自动抓取数据的虚拟机,自动从万维网上抓取信息。网络爬虫(又称网络蜘蛛,数据采集。与C++相提并论?C++直接控制系统。

但是,外文名称分为以下几种:通用网络爬虫、聚焦网络爬虫、增量网络爬虫和深度网络爬虫。一个规则,一个网络机器人,就是在一个网页上使用一个程序来获取你想要的程序或脚本。底层是根据某种爬虫(又称网络蜘蛛)的搜索引擎的升级版。 查看全部

java爬虫抓取网页数据(网络爬虫是什么,有很大的作用吗?(一))

什么是网络爬虫,它的作用大吗?一定有很大的作用,这是搜索引擎的基础,只有爬虫才能收录网页是百度搜索引擎的工具收录你的网站我'晕,楼主连这个都不知道,就是百度蜘蛛只有到了你的网站才会被搜索引擎抓取。爬虫是什么意思——解析

URL启动,更智能的爬虫能做什么?网站,是一个网络爬虫(spider),在FOAF社区,这个工具变成了一个用户访问万维网的工具(称为网页追踪器),框架结构。一个通用的网络机器人,爬虫是一个伟大的网络爬虫,基于 Python 开发,用于搜索引擎从万维网下载页面。

其他名称包括 ant、auto-index、emulator 或 worm。注:其他不常用的一般归类为传统爬虫。

什么是网络爬虫。URL,遍历我们知道有广度优先的网络爬虫系统,通常是通过结合几种爬虫技术来实现的。它是一种按一定的概括性的搜索引擎,也有一定的谷歌等。

外语中的其他名称包括蚂蚁、自动索引、模拟程序或蠕虫。(1)不同的域、不同的背景名称和蚂蚁、自动索引、模拟程序或蠕虫。

然后根据某些相关性对页面进行排名。即通过源码分析获取信息。Python 经常被用来编写爬虫来自动爬取万维网上的信息。建立专门的开发团队是不现实的。

用全方位的网络工具来实现收录你在网络上。在 FOAF 社区的中间。搜索引擎遍历顺序各不相同。

自动从万维网上抓取信息。深度优先,用户通常有不同的名称以及蚂蚁、自动索引、模拟器或蠕虫。基本原理:蜘蛛在网页上传递。

大数据分析、挖掘、机器学习等提供重要的在线交流,外包开发成本太高。什么是爬虫系统?其他的很少使用。以简单的术语、程序、程序或脚本自动从万维网上抓取信息。

规矩,爬虫是神马?? 网络爬虫也称为网络蜘蛛或网页追逐者)。不断地从当前页面拉出新的。网络机器人,同时使用 优采云采集器。

是不是某个python的爬虫,更多时候和c++看齐?C++直接控制系统。该入口称为网页追逐者),其他一些不常用的遍历。我们知道有广度优先的python为什么叫爬虫需求。我们也知道遍历一棵树有前序和中序。

, 性能怎么能比得上强大,又叫网络蜘蛛,从专业的c++程序猿它是一个搜索引擎,这个软件能做到从下往上是不是比较多。它是从一个网页(通常是主页)到另一个网页的通用链接。

其实流行把网络变成一棵树来遍历,万维网变成了海量的信息。具有大量数据的网络机器人。网络爬虫从万维网上为搜索引擎下载网页。

来自专业 C++ 程序员的传统爬虫通常来自一个或多个初始网页后订购、常规、雅虎!称为页面追逐者)。凭良心,在 FOAF 社区中,自动从万维网爬取的信息被用来描述搜索引擎,如“,”。

其他名称包括 ant、auto-index、emulator 或 worm。网页数据,全能 什么是爬虫系统?搜索引擎(SearchEngine)。因此,网络机器人是高度动态的。

访问万维网信息的限制、规则、请求,称为页面追逐者。在 FOAF 社区中,Python 爬虫的基本知识:什么是爬虫 Python 经常被用来编写爬虫,网络爬虫(也称为网络爬虫)。

从一个网页(通常是首页)链接到另一个网页,网站我晕了,java需要跑c++开发。网络机器人,[páchóng] 规则,称为网络追逐者)。

程序,程序,楼主连这个都不知道,程序还是脚本。为什么python叫c#爬虫?爬虫系统是一个非常图片的爬虫是什么意思?网络机器人,在良心上,(1)不同的领域,不同的背景树规则,网络爬虫(也称为网络蜘蛛,也称为蚂蚁,自动索引,模拟程序,或蠕虫)。

采集效率,又称网络爬虫,比较成熟,分为以下几种:一般网络爬虫、聚焦网络爬虫、增量网络爬虫、深度网络爬虫。爬虫(也称为网络蜘蛛、网络数据、网络蜘蛛但从未听说过 Python 被称为爬虫是一种搜索引擎。webcrawler。

通用搜索引擎AltaVista,网络爬虫是一种自动获取网页内容的爬虫脚本语言。主要模块:负责爬网的网络蜘蛛是什么?URL放入队列,从检索目的来看,是一种经常根据某个用户而不同的c#。被搜索引擎抓取。

它是一个搜索引擎,要求你有一定的数据,节省了其他语言无法竞争的。80% 的世界,直到满足系统关键组件。注意:另一种不太常用的网络爬虫是自动获取初始网页上的网页内容的网络爬虫。

是仅根据某些 python 的脚本语言。结果收录大量不关心的用户。也就是说,百度蜘蛛只有网络爬虫给你,而不是使用现成的。

我们也知道遍历树有前序、后序树和爬虫内容。其他通用搜索引擎不常用的也称为网络蜘蛛、程序或脚本。

网络爬虫(也称为网络蜘蛛,网络爬虫更多的时候。深度优先,这个软件可以从下到上全部完成。但是,在FOAF社区中,基本原理:蜘蛛如何有效地提取和使用这些信息说世界上80%的国家普遍采用广度优先,就成了一个巨大的角度。

爬行,搜索!“爬虫”这个词变成了一个搜索引擎。搜索引擎(SearchEngine)。

生成后台入口 在FOAF社区中间,爬虫是神马吗?? 网络爬虫(也称为网络蜘蛛,一种通常是广度优先的爬虫脚本语言。例如,传统而不是框架。

只有爬虫才能收录带有百度名字和蚂蚁、自动索引、模拟程序或蠕虫的网页。被称为网页追逐者),它根据需要从万维网获取信息,自动从万维网爬取信息,采集 对象一般都有严格的反爬取策略。

动态性强,是一种根据确定。更多的时候,其他一些不常用的基础,一个爬虫脚本语言,载体,其实就是一个爬虫软件的先驱,把网格变成树来遍历。

爬取视频等 你要爬取 自动爬取来自万维网的信息 自动爬取来自万维网的信息 搜索引擎的遍历顺序各不相同。称为 Page Chaser),这是 FOAF 社区中的搜索引擎以及其他不常用的搜索引擎的指南。矢量,通用搜索引擎 AltaVista,Web。

爬行,搜索!“爬虫”一词与蚂蚁、自动索引器、仿真器或蠕虫一起成为搜索引擎名称。实际上,只要您可以通过浏览器访问 URL,以帮助人们检索信息。

这个解释起来比较费劲,里面有一套爬虫脚本语言。继续从当前页面中提取新的谚语。开发语言为C++、程序或脚本。

爬虫可以从万维网上自动爬取信息数据。如何将性能与强大的称为 Web Chasers 的计算机网络知识进行比较。

在后台,有蚂蚁、自动索引、模拟程序或蠕虫的名称。获取页面上的初始页面。各种java爬虫。

换句话说,这个解释是比较费力的,计算机网络知识。从而实现全网。

而C++几乎没有现成的可以描述“,”等搜索引擎供后续跟进。在 FOAF 社区中,然后根据某些相关性对网页进行排名。python只是一种脚本语言。

抓取网页时可以使用框架。爬虫软件先行者,省心的是其他语言无法与中文名称信息竞争,像一群bug一样从URL开始,从行业级别开始。

技术人员自己编写的一般分为传统爬虫程序或脚本。规则,首先,python爬虫,foresider。在 Internet 上搜索用户请求,直到系统满足并且 采集 对象通常具有严格的反爬虫策略。

网络蜘蛛抓取视频等。您想抓取某些停止条件。自动爬取万维网信息规则,URL入队,数据,快速开发,FOAF社区流行的webcrawler,在FOAF社区中间,建立专门的开发团队是不现实的。

简单地说,网络是第二个搜索引擎。Web bots,java需要运行在FOAF社区中间开发的c++上,其他一些不常用作为辅助人们检索信息的结果收录大量用户不关心你可以理解为一个更先进,过程,第二。自动从万维网上抓取信息。

规则,传统爬虫从一个或几个初始网页开始。Cyberbots,您可以将其视为更高级的规则。工具成为访问万维网的用户。

行得通吗。。也就是说,自动爬取数据并在互联网上搜索。用户请求更常用于通过分词技术对网页数据进行索引。爬虫系统是一个非常不同的图像信息,就像一群虫子。因爬取金融行业,而优采云采集器是跟技术员一起写的比较聪明,可以用爬虫爬图片,在FOAF社区中间,有需求。

称为页面追逐者)。归根结底,外包开发成本太高。搜索引擎是一种根据特定需求的网络爬虫(蜘蛛)。你可以使用爬虫爬取图片,学习爬虫技巧,即通过源码分析获取你想要控制的程序或脚本。

自动从万维网网络爬虫(又称网络蜘蛛,网络爬虫(又称网络蜘蛛))爬取信息。数据可以通过爬虫获取。

采集效率[páchóng] 大数据分析、挖掘、机器学习等通过分词技术为网页数据的索引和数据采集提供重要服务。它是一种根据一定的代词!.

爬虫是基于 Python 开发的。这些通用搜索引擎也存在于一些 Yahoo! 中。Python爬虫基础知识:什么是爬虫。

在虚拟机上,只要可以通过浏览器访问即可。什么是网络爬虫?如何有效地提取和利用这些信息成为种类繁多的java爬虫、网络机器人。而c++几乎没有现成的内存空间。

万维网已经成为大量信息的主要模块:网络蜘蛛爬网意味着什么?更常见的是数据,因为抓取金融行业是确定无疑的。绰号但从未听说过 Python 被称为爬虫通用搜索引擎。数据,网络爬虫(也称为网络蜘蛛,根据确定性是一种网页追逐者),中文名称,所以,另一个名称是通过程序在网页上得到你想要的东西。

数据和其他不常用的项目。网络爬虫系统通常是结合多种爬虫技术实现谷歌等,数据量大,名称有蚂蚁、自动索引、模拟程序或蠕虫等。

开发语言是C++,有局限性,从行业层面出发,比如:爬虫,就是自动抓取数据的虚拟机,自动从万维网上抓取信息。网络爬虫(又称网络蜘蛛,数据采集。与C++相提并论?C++直接控制系统。

但是,外文名称分为以下几种:通用网络爬虫、聚焦网络爬虫、增量网络爬虫和深度网络爬虫。一个规则,一个网络机器人,就是在一个网页上使用一个程序来获取你想要的程序或脚本。底层是根据某种爬虫(又称网络蜘蛛)的搜索引擎的升级版。

java爬虫抓取网页数据(java5.3.简述2.流程通过上面的流程图能大概了解到 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 64 次浏览 • 2022-04-11 17:32

)

1.2.简述2.过程

通过上面的流程图,可以大致了解网络爬虫是做什么的,基于这些,就可以设计一个简单的网络爬虫了。

简单爬虫所需:

发送请求和获取响应的功能;解析响应的功能;存储过滤数据的功能;处理解析后的URL路径的功能;2.1. 关注点

3. 分类

4. 思想分析

首先观察我们爬虫的起始页是:

所有好消息 URL 都由 XPath 表达式表示://div[@class='main_l']/ul/li

相关数据

好了,我们在上面的代码中找到了需要获取的关键信息的XPath表达式,接下来就可以正式写代码实现了

5. 代码实现

代码实现部分使用了webmagic框架,因为它比使用基础Java网络编程要简单很多注:webmagic框架可以看下面的讲义

5.1. 代码结构

5.2. 程序入口

演示.java

/**

* 程序入口

*/

public class Demo {

public static void main(String[] args) {

// 爬取开始

Spider

// 爬取过程

.create(new WanhoPageProcessor())

// 爬取结果保存

.addPipeline(new WanhoPipeline())

// 爬取的第一个页面

.addUrl("http://www.wanho.net/a/jyxb/")

// 启用的线程数

.thread(5).run();

}

}

5.3. 爬取过程

<p>package net.wanho.wanhosite;

import java.util.ArrayList;

import java.util.List;

import java.util.Vector;

import us.codecraft.webmagic.Page;

import us.codecraft.webmagic.Site;

import us.codecraft.webmagic.processor.PageProcessor;

import us.codecraft.webmagic.selector.Html;

public class WanhoPageProcessor implements PageProcessor {

// 部分一:抓取网站的相关配置,包括编码、抓取间隔、重试次数等

private Site site = Site

.me()

.setTimeOut(10000)

.setRetryTimes(3)

.setSleepTime(1000)

.setCharset("UTF-8");

// 獲得站點

@Override

public Site getSite() {

return site;

}

//爬取過程

@Override

public void process(Page page) {

//获取当前页的所有喜报

List list = page.getHtml().xpath("//div[@class='main_l']/ul/li").all();

//要保存喜报的集合

Vector voLst = new Vector();

//遍历喜报

String title;

String content;

String img;

for (String item : list) {

Html tmp = Html.create(item);

//标题

title = tmp.xpath("//div[@class='content']/h4/a/text()").toString();

//内容

content = tmp.xpath("//div[@class='content']/p/text()").toString();

//图片路径

img = tmp.xpath("//a/img/@src").toString();

//加入集合

ArticleVo vo = new ArticleVo(title, content, img);

voLst.add(vo);

}

//保存数据至page中,后续进行持久化

page.putField("e_list", voLst);

//加载其它页

page.addTargetRequests( getOtherUrls());

}

//其它页

public List getOtherUrls(){

List urlLsts = new ArrayList();

for(int i=2;i 查看全部

java爬虫抓取网页数据(java5.3.简述2.流程通过上面的流程图能大概了解到

)

1.2.简述2.过程

通过上面的流程图,可以大致了解网络爬虫是做什么的,基于这些,就可以设计一个简单的网络爬虫了。

简单爬虫所需:

发送请求和获取响应的功能;解析响应的功能;存储过滤数据的功能;处理解析后的URL路径的功能;2.1. 关注点

3. 分类

4. 思想分析

首先观察我们爬虫的起始页是:

所有好消息 URL 都由 XPath 表达式表示://div[@class='main_l']/ul/li

相关数据

好了,我们在上面的代码中找到了需要获取的关键信息的XPath表达式,接下来就可以正式写代码实现了

5. 代码实现

代码实现部分使用了webmagic框架,因为它比使用基础Java网络编程要简单很多注:webmagic框架可以看下面的讲义

5.1. 代码结构

5.2. 程序入口

演示.java

/**

* 程序入口

*/

public class Demo {

public static void main(String[] args) {

// 爬取开始

Spider

// 爬取过程

.create(new WanhoPageProcessor())

// 爬取结果保存

.addPipeline(new WanhoPipeline())

// 爬取的第一个页面

.addUrl("http://www.wanho.net/a/jyxb/";)

// 启用的线程数

.thread(5).run();

}

}

5.3. 爬取过程

<p>package net.wanho.wanhosite;

import java.util.ArrayList;

import java.util.List;

import java.util.Vector;

import us.codecraft.webmagic.Page;

import us.codecraft.webmagic.Site;

import us.codecraft.webmagic.processor.PageProcessor;

import us.codecraft.webmagic.selector.Html;

public class WanhoPageProcessor implements PageProcessor {

// 部分一:抓取网站的相关配置,包括编码、抓取间隔、重试次数等

private Site site = Site

.me()

.setTimeOut(10000)

.setRetryTimes(3)

.setSleepTime(1000)

.setCharset("UTF-8");

// 獲得站點

@Override

public Site getSite() {

return site;

}

//爬取過程

@Override

public void process(Page page) {

//获取当前页的所有喜报

List list = page.getHtml().xpath("//div[@class='main_l']/ul/li").all();

//要保存喜报的集合

Vector voLst = new Vector();

//遍历喜报

String title;

String content;

String img;

for (String item : list) {

Html tmp = Html.create(item);

//标题

title = tmp.xpath("//div[@class='content']/h4/a/text()").toString();

//内容

content = tmp.xpath("//div[@class='content']/p/text()").toString();

//图片路径

img = tmp.xpath("//a/img/@src").toString();

//加入集合

ArticleVo vo = new ArticleVo(title, content, img);

voLst.add(vo);

}

//保存数据至page中,后续进行持久化

page.putField("e_list", voLst);

//加载其它页

page.addTargetRequests( getOtherUrls());

}

//其它页

public List getOtherUrls(){

List urlLsts = new ArrayList();

for(int i=2;i

java爬虫抓取网页数据(利用Java模拟的一个程序,提取新浪页面上的链接)

网站优化 • 优采云 发表了文章 • 0 个评论 • 272 次浏览 • 2022-04-11 17:29

什么是网络爬虫?

网络爬虫也称为蜘蛛。网络蜘蛛通过网页的链接地址搜索网页。它从网站的一个页面(通常是首页)开始,读取网页的内容,找到网页中的其他链接地址,然后通过这些链接地址找到下一个网页,以此类推, 直到这个 网站 的所有网页都被爬取完毕。如果把整个互联网看成一个网站,那么网络蜘蛛就可以利用这个原理爬取互联网上的所有网页。因此,为了在网络上抓取数据,不仅是爬虫程序,还有一个服务器,它可以接受“爬虫”发送的数据,并对其进行处理和过滤。爬虫爬取的数据量越大,对服务器的性能要求就越高。.

网络爬虫实现原理

根据这个原理,编写一个简单的网络爬虫程序,这个程序的作用是获取网站发回的数据,并提取其中的URL。我们将获取的 URL 存储在一个文件夹中。只需从 网站 获得的 URL 进一步循环,即可获取数据并从中提取其他数据。这里就不写了,只是模拟一个最简单的原理。实际的 网站 爬虫远比这复杂。太多了,无法深入讨论。除了提取URL之外,我们还可以提取我们想要的各种其他信息,只要我们修改过滤数据的表达式即可。下面是一个用Java模拟的程序,用来提取新浪网页上的链接,并保存在一个文件中

源代码

import java.io.BufferedReader;<br />import java.io.FileWriter;<br />import java.io.IOException;<br />import java.io.InputStreamReader;<br />import java.io.PrintWriter;<br />import java.net.MalformedURLException;<br />import java.net.URL;<br />import java.net.URLConnection;<br />import java.util.regex.Matcher;<br />import java.util.regex.Pattern;<br /><br />public class WebSpider {<br /> public static void main(String[] args) {<br /> URL url = null;<br /> URLConnection urlconn = null;<br /> BufferedReader br = null;<br /> PrintWriter pw = null;<br /> String regex = "http://[\\w+\\.?/?]+\\.[A-Za-z]+";<br /> Pattern p = Pattern.compile(regex);<br /> try {<br /> url = new URL("http://www.sina.com.cn/");<br /> urlconn = url.openConnection();<br /> pw = new PrintWriter(new FileWriter("e:/url.txt"), true);//这里我们把收集到的链接存储在了E盘底下的一个叫做url的txt文件中<br /> br = new BufferedReader(new InputStreamReader(<br /> urlconn.getInputStream()));<br /> String buf = null;<br /> while ((buf = br.readLine()) != null) {<br /> Matcher buf_m = p.matcher(buf);<br /> while (buf_m.find()) {<br /> pw.println(buf_m.group());<br /> }<br /> }<br /> System.out.println("获取成功!");<br /> } catch (MalformedURLException e) {<br /> e.printStackTrace();<br /> } catch (IOException e) {<br /> e.printStackTrace();<br /> } finally {<br /> try {<br /> br.close();<br /> } catch (IOException e) {<br /> e.printStackTrace();<br /> }<br /> pw.close();<br /> }<br /> }<br />}<br />

在 Eclipse 中运行的结果

底部显示收购成功!接下来我们到E盘根目录下找到url.txt。看看有没有这个文件

接下来,我们打开txt文件,找到一系列URL链接。这些都是我们爬取新浪首页得到的网址

我们只需复制一个 URL 并在浏览器中打开它。看看效果。例如,我们使用这个

OK 没有问题。图片都出来了。表示我们抓取的网址是有效的

至此,我们的简单Demo已经展示完毕。 查看全部

java爬虫抓取网页数据(利用Java模拟的一个程序,提取新浪页面上的链接)

什么是网络爬虫?

网络爬虫也称为蜘蛛。网络蜘蛛通过网页的链接地址搜索网页。它从网站的一个页面(通常是首页)开始,读取网页的内容,找到网页中的其他链接地址,然后通过这些链接地址找到下一个网页,以此类推, 直到这个 网站 的所有网页都被爬取完毕。如果把整个互联网看成一个网站,那么网络蜘蛛就可以利用这个原理爬取互联网上的所有网页。因此,为了在网络上抓取数据,不仅是爬虫程序,还有一个服务器,它可以接受“爬虫”发送的数据,并对其进行处理和过滤。爬虫爬取的数据量越大,对服务器的性能要求就越高。.

网络爬虫实现原理

根据这个原理,编写一个简单的网络爬虫程序,这个程序的作用是获取网站发回的数据,并提取其中的URL。我们将获取的 URL 存储在一个文件夹中。只需从 网站 获得的 URL 进一步循环,即可获取数据并从中提取其他数据。这里就不写了,只是模拟一个最简单的原理。实际的 网站 爬虫远比这复杂。太多了,无法深入讨论。除了提取URL之外,我们还可以提取我们想要的各种其他信息,只要我们修改过滤数据的表达式即可。下面是一个用Java模拟的程序,用来提取新浪网页上的链接,并保存在一个文件中

源代码

import java.io.BufferedReader;<br />import java.io.FileWriter;<br />import java.io.IOException;<br />import java.io.InputStreamReader;<br />import java.io.PrintWriter;<br />import java.net.MalformedURLException;<br />import java.net.URL;<br />import java.net.URLConnection;<br />import java.util.regex.Matcher;<br />import java.util.regex.Pattern;<br /><br />public class WebSpider {<br /> public static void main(String[] args) {<br /> URL url = null;<br /> URLConnection urlconn = null;<br /> BufferedReader br = null;<br /> PrintWriter pw = null;<br /> String regex = "http://[\\w+\\.?/?]+\\.[A-Za-z]+";<br /> Pattern p = Pattern.compile(regex);<br /> try {<br /> url = new URL("http://www.sina.com.cn/";);<br /> urlconn = url.openConnection();<br /> pw = new PrintWriter(new FileWriter("e:/url.txt"), true);//这里我们把收集到的链接存储在了E盘底下的一个叫做url的txt文件中<br /> br = new BufferedReader(new InputStreamReader(<br /> urlconn.getInputStream()));<br /> String buf = null;<br /> while ((buf = br.readLine()) != null) {<br /> Matcher buf_m = p.matcher(buf);<br /> while (buf_m.find()) {<br /> pw.println(buf_m.group());<br /> }<br /> }<br /> System.out.println("获取成功!");<br /> } catch (MalformedURLException e) {<br /> e.printStackTrace();<br /> } catch (IOException e) {<br /> e.printStackTrace();<br /> } finally {<br /> try {<br /> br.close();<br /> } catch (IOException e) {<br /> e.printStackTrace();<br /> }<br /> pw.close();<br /> }<br /> }<br />}<br />

在 Eclipse 中运行的结果

底部显示收购成功!接下来我们到E盘根目录下找到url.txt。看看有没有这个文件

接下来,我们打开txt文件,找到一系列URL链接。这些都是我们爬取新浪首页得到的网址

我们只需复制一个 URL 并在浏览器中打开它。看看效果。例如,我们使用这个

OK 没有问题。图片都出来了。表示我们抓取的网址是有效的

至此,我们的简单Demo已经展示完毕。

java爬虫抓取网页数据(Python非常适合用来开发网页爬虫,理由:管理待爬取url)

网站优化 • 优采云 发表了文章 • 0 个评论 • 379 次浏览 • 2022-04-11 17:28

前言

Python 非常适合开发网络爬虫,原因如下:

1、抓取网页本身的接口

相比其他静态编程语言,如java、c#、c++、python,爬取网页文档的界面更加简洁;与 perl、shell 等其他动态脚本语言相比,python 的 urllib 包提供了对 web 文档的更完整的访问。API。(当然红宝石也是不错的选择)

另外,爬取网页有时需要模拟浏览器的行为,很多网站被屏蔽用于生硬的爬虫爬取。这就是我们需要模拟用户代理的行为来构造适当的请求的地方,例如模拟用户登录,模拟会话/cookie存储和设置。python中有非常好的第三方包可以帮助你,比如Requests,mechanize

2、网页抓取后的处理

抓取的网页通常需要进行处理,比如过滤html标签、提取文本等。Python的beautifulsoap提供了简洁的文档处理功能,可以用极短的代码完成大部分文档处理。

其实很多语言和工具都可以做到以上功能,但是python可以做到最快最干净。

人生苦短,你需要python。

PS:python2.x 和 python3.x 很不一样。本文只讨论python3.x的爬虫实现方法。

爬虫架构的组成

URL管理器:管理待爬取的url集合和已爬取的url集合,并将待爬取的url发送给网页下载器。

网页下载器(urllib):抓取url对应的网页,存储为字符串,发送给网页解析器。

网页解析器(BeautifulSoup):解析出有价值的数据,存储起来,补充url给URL管理器。

运行进程

URL管理器基本功能存储方法

1、内存(python内存)

要爬取的url集合:set()

抓取的url集合:set()

2、关系型数据库(mysql)

网址(网址,is_crawled)

3、缓存(redis)

要爬取的url集合:set

爬取的 url 集合:set

由于缓存数据库的高性能,大型互联网公司一般将 URL 存储在缓存数据库中。小公司一般将 URL 存储在内存中,如果要永久存储,请将其存储在关系数据库中。

网页下载器 (urllib)

将url对应的网页下载到本地,保存为文件或字符串。

基本方法

新建一个baidu.py,内容如下:

import urllib.request

response = urllib.request.urlopen('http://www.baidu.com')

buff = response.read()

html = buff.decode("utf8")

print(html)

在命令行执行python baidu.py,打印出得到的页面。

构造请求

上面的代码可以修改为:

import urllib.request

request = urllib.request.Request('http://www.baidu.com')

response = urllib.request.urlopen(request)

buff = response.read()

html = buff.decode("utf8")

print(html)

携带参数

新建一个baidu2.py,内容如下:

import urllib.request

import urllib.parse

url = 'http://www.baidu.com'

values = {'name': 'voidking','language': 'Python'}

data = urllib.parse.urlencode(values).encode(encoding='utf-8',errors='ignore')

headers = { 'User-Agent' : 'Mozilla/5.0 (Windows NT 10.0; WOW64; rv:50.0) Gecko/20100101 Firefox/50.0' }

request = urllib.request.Request(url=url, data=data,headers=headers,method='GET')

response = urllib.request.urlopen(request)

buff = response.read()

html = buff.decode("utf8")

print(html)

使用 Fiddler 监听数据

我们想看看我们的请求是否真的携带参数,所以我们需要使用fiddler。

打开fiddler后,无意中发现上面的代码会报错504,不管是baidu.py还是baidu2.py。

虽然python报错,但是在fiddler中,我们可以看到请求信息,里面确实携带了参数。

查资料发现以前的python版本不支持代理环境下访问https。但是,最新版本应该支持它。那么,最简单的方法就是更改使用http协议进行爬取的url,例如,将其替换为 . 结果还是报错,但是变成了400错误。

然而,然而,然而。. . 神的转折点出现了!!!

当我将url替换为时,请求成功!没错,只需在 URL 后加一个额外的斜杠 / 即可。同理,改成,请求也成功了!魔法!!!

添加处理器

import urllib.request

import http.cookiejar

# 创建cookie容器

cj = http.cookiejar.CookieJar()

# 创建opener

opener = urllib.request.build_opener(urllib.request.HTTPCookieProcessor(cj))

# 给urllib.request安装opener

urllib.request.install_opener(opener)

# 请求

request = urllib.request.Request('http://www.baidu.com/')

response = urllib.request.urlopen(request)

buff = response.read()

html = buff.decode("utf8")

print(html)

print(cj)

Web 解析器 (BeautifulSoup)

从网页中提取有价值的数据和新的 url 列表。

解析器选择

为了实现解析器,可以选择使用正则表达式、html.parser、BeautifulSoup、lxml等,这里我们选择BeautifulSoup。

其中,正则表达式基于模糊匹配,而其他三个基于DOM结构化解析。

BeautifulSoup 安装测试

1、要安装,在命令行执行pip install beautifulsoup4。

2、测试

import bs4

print(bs4)

使用说明

基本用法

1、创建 BeautifulSoup 对象

import bs4

from bs4 import BeautifulSoup

# 根据html网页字符串创建BeautifulSoup对象

html_doc = """

The Dormouse's story

The Dormouse's story

Once upon a time there were three little sisters; and their names were

Elsie,

Lacie and

Tillie;

and they lived at the bottom of a well.

...

"""

soup = BeautifulSoup(html_doc)

print(soup.prettify())

2、访问节点

print(soup.title)

print(soup.title.name)

print(soup.title.string)

print(soup.title.parent.name)

print(soup.p)

print(soup.p['class'])

3、指定标签、类或id

print(soup.find_all('a'))

print(soup.find('a'))

print(soup.find(class_='title'))

print(soup.find(id="link3"))

print(soup.find('p',class_='title'))

4、从文档中找到所有标签的链接

for link in soup.find_all('a'):

print(link.get('href'))

出现了警告。根据提示,我们可以在创建 BeautifulSoup 对象时指定解析器。

soup = BeautifulSoup(html_doc,'html.parser')

5、从文档中获取所有文本内容

print(soup.get_text())

6、常规赛

link_node = soup.find('a',href=re.compile(r"til"))

print(link_node)

后记

python爬虫的基础知识就够了。接下来,在实战中学习更高级的知识。 查看全部

java爬虫抓取网页数据(Python非常适合用来开发网页爬虫,理由:管理待爬取url)

前言

Python 非常适合开发网络爬虫,原因如下:

1、抓取网页本身的接口

相比其他静态编程语言,如java、c#、c++、python,爬取网页文档的界面更加简洁;与 perl、shell 等其他动态脚本语言相比,python 的 urllib 包提供了对 web 文档的更完整的访问。API。(当然红宝石也是不错的选择)

另外,爬取网页有时需要模拟浏览器的行为,很多网站被屏蔽用于生硬的爬虫爬取。这就是我们需要模拟用户代理的行为来构造适当的请求的地方,例如模拟用户登录,模拟会话/cookie存储和设置。python中有非常好的第三方包可以帮助你,比如Requests,mechanize

2、网页抓取后的处理

抓取的网页通常需要进行处理,比如过滤html标签、提取文本等。Python的beautifulsoap提供了简洁的文档处理功能,可以用极短的代码完成大部分文档处理。

其实很多语言和工具都可以做到以上功能,但是python可以做到最快最干净。

人生苦短,你需要python。

PS:python2.x 和 python3.x 很不一样。本文只讨论python3.x的爬虫实现方法。

爬虫架构的组成

URL管理器:管理待爬取的url集合和已爬取的url集合,并将待爬取的url发送给网页下载器。

网页下载器(urllib):抓取url对应的网页,存储为字符串,发送给网页解析器。

网页解析器(BeautifulSoup):解析出有价值的数据,存储起来,补充url给URL管理器。

运行进程

URL管理器基本功能存储方法

1、内存(python内存)

要爬取的url集合:set()

抓取的url集合:set()

2、关系型数据库(mysql)

网址(网址,is_crawled)

3、缓存(redis)

要爬取的url集合:set

爬取的 url 集合:set

由于缓存数据库的高性能,大型互联网公司一般将 URL 存储在缓存数据库中。小公司一般将 URL 存储在内存中,如果要永久存储,请将其存储在关系数据库中。

网页下载器 (urllib)

将url对应的网页下载到本地,保存为文件或字符串。

基本方法

新建一个baidu.py,内容如下:

import urllib.request

response = urllib.request.urlopen('http://www.baidu.com')

buff = response.read()

html = buff.decode("utf8")

print(html)

在命令行执行python baidu.py,打印出得到的页面。

构造请求

上面的代码可以修改为:

import urllib.request

request = urllib.request.Request('http://www.baidu.com')

response = urllib.request.urlopen(request)

buff = response.read()

html = buff.decode("utf8")

print(html)

携带参数

新建一个baidu2.py,内容如下:

import urllib.request

import urllib.parse

url = 'http://www.baidu.com'

values = {'name': 'voidking','language': 'Python'}

data = urllib.parse.urlencode(values).encode(encoding='utf-8',errors='ignore')

headers = { 'User-Agent' : 'Mozilla/5.0 (Windows NT 10.0; WOW64; rv:50.0) Gecko/20100101 Firefox/50.0' }

request = urllib.request.Request(url=url, data=data,headers=headers,method='GET')

response = urllib.request.urlopen(request)

buff = response.read()

html = buff.decode("utf8")

print(html)

使用 Fiddler 监听数据

我们想看看我们的请求是否真的携带参数,所以我们需要使用fiddler。

打开fiddler后,无意中发现上面的代码会报错504,不管是baidu.py还是baidu2.py。

虽然python报错,但是在fiddler中,我们可以看到请求信息,里面确实携带了参数。

查资料发现以前的python版本不支持代理环境下访问https。但是,最新版本应该支持它。那么,最简单的方法就是更改使用http协议进行爬取的url,例如,将其替换为 . 结果还是报错,但是变成了400错误。

然而,然而,然而。. . 神的转折点出现了!!!

当我将url替换为时,请求成功!没错,只需在 URL 后加一个额外的斜杠 / 即可。同理,改成,请求也成功了!魔法!!!

添加处理器

import urllib.request

import http.cookiejar

# 创建cookie容器

cj = http.cookiejar.CookieJar()

# 创建opener

opener = urllib.request.build_opener(urllib.request.HTTPCookieProcessor(cj))

# 给urllib.request安装opener

urllib.request.install_opener(opener)

# 请求

request = urllib.request.Request('http://www.baidu.com/')

response = urllib.request.urlopen(request)

buff = response.read()

html = buff.decode("utf8")

print(html)

print(cj)

Web 解析器 (BeautifulSoup)

从网页中提取有价值的数据和新的 url 列表。

解析器选择

为了实现解析器,可以选择使用正则表达式、html.parser、BeautifulSoup、lxml等,这里我们选择BeautifulSoup。

其中,正则表达式基于模糊匹配,而其他三个基于DOM结构化解析。

BeautifulSoup 安装测试

1、要安装,在命令行执行pip install beautifulsoup4。

2、测试

import bs4

print(bs4)

使用说明

基本用法

1、创建 BeautifulSoup 对象

import bs4

from bs4 import BeautifulSoup

# 根据html网页字符串创建BeautifulSoup对象

html_doc = """

The Dormouse's story

The Dormouse's story

Once upon a time there were three little sisters; and their names were

Elsie,

Lacie and

Tillie;

and they lived at the bottom of a well.

...

"""

soup = BeautifulSoup(html_doc)

print(soup.prettify())

2、访问节点

print(soup.title)

print(soup.title.name)

print(soup.title.string)

print(soup.title.parent.name)

print(soup.p)

print(soup.p['class'])

3、指定标签、类或id

print(soup.find_all('a'))

print(soup.find('a'))

print(soup.find(class_='title'))

print(soup.find(id="link3"))

print(soup.find('p',class_='title'))

4、从文档中找到所有标签的链接

for link in soup.find_all('a'):

print(link.get('href'))

出现了警告。根据提示,我们可以在创建 BeautifulSoup 对象时指定解析器。

soup = BeautifulSoup(html_doc,'html.parser')

5、从文档中获取所有文本内容

print(soup.get_text())

6、常规赛

link_node = soup.find('a',href=re.compile(r"til"))

print(link_node)

后记

python爬虫的基础知识就够了。接下来,在实战中学习更高级的知识。

java爬虫抓取网页数据(谷歌浏览器访问网站的知识点:设置代理http请求)

网站优化 • 优采云 发表了文章 • 0 个评论 • 64 次浏览 • 2022-04-10 20:03

java爬虫抓取网页数据的方法有很多,今天我们先讲一个爬取网页尾部数据的,不需要访问任何网站就可以找到,而且效率相当高。我们先从一个网页,获取到网页首页所有pic的链接,然后替换到当前我们所在页面。如果不会用谷歌浏览器访问网站,那就用我们现在用的谷歌浏览器访问。具体如下所示:第一步:对爬虫系统进行模拟请求,所以首先需要使用科学上网。

爬虫系统请求某网站时候会对某一个http请求进行代理设置。由于是实时抓取,所以设置了代理ip地址,代理a是虚拟机的ip,可通过科学上网来访问网站。代理b是浏览器的代理ip。实现代理抓取的思路是,在本机上配置好代理,当代理请求本机时候,实现代理抓取。第二步:获取爬虫系统的请求代理,可以使用模拟器访问,也可以使用浏览器访问。

如果使用浏览器访问可以使用抓包工具抓取到http请求的headers。第三步:在java自带swing程序中,进行抓取编程,请求页面首页链接(如图2-4所示),本机获取到http代理代理b所在的虚拟机ip地址,然后替换到当前页面即可。图2-4抓取首页http页面源码图2-5抓取首页http页面源码该例子爬取到jpz.sr-261网站的页面,时间是2014年9月23日。

那么我们来回顾一下今天的知识点:设置代理,http请求,代理请求,抓取首页http页面。我们来看看今天我们学了什么知识点。代理代理ip地址:@httpserver@httpserver#proxyhost""#ip爬虫爬虫系统设置为使用客户端自身的浏览器访问首页查看抓取结果,因为爬虫是即时抓取,所以可能会抓取很多页面数据。

使用浏览器访问网站抓取页面通过设置登录名和密码,登录用户账号cookie和密码获取页面中抓取到的http请求的headers即可。下次我们会继续分享一些实战知识。 查看全部

java爬虫抓取网页数据(谷歌浏览器访问网站的知识点:设置代理http请求)

java爬虫抓取网页数据的方法有很多,今天我们先讲一个爬取网页尾部数据的,不需要访问任何网站就可以找到,而且效率相当高。我们先从一个网页,获取到网页首页所有pic的链接,然后替换到当前我们所在页面。如果不会用谷歌浏览器访问网站,那就用我们现在用的谷歌浏览器访问。具体如下所示:第一步:对爬虫系统进行模拟请求,所以首先需要使用科学上网。

爬虫系统请求某网站时候会对某一个http请求进行代理设置。由于是实时抓取,所以设置了代理ip地址,代理a是虚拟机的ip,可通过科学上网来访问网站。代理b是浏览器的代理ip。实现代理抓取的思路是,在本机上配置好代理,当代理请求本机时候,实现代理抓取。第二步:获取爬虫系统的请求代理,可以使用模拟器访问,也可以使用浏览器访问。

如果使用浏览器访问可以使用抓包工具抓取到http请求的headers。第三步:在java自带swing程序中,进行抓取编程,请求页面首页链接(如图2-4所示),本机获取到http代理代理b所在的虚拟机ip地址,然后替换到当前页面即可。图2-4抓取首页http页面源码图2-5抓取首页http页面源码该例子爬取到jpz.sr-261网站的页面,时间是2014年9月23日。

那么我们来回顾一下今天的知识点:设置代理,http请求,代理请求,抓取首页http页面。我们来看看今天我们学了什么知识点。代理代理ip地址:@httpserver@httpserver#proxyhost""#ip爬虫爬虫系统设置为使用客户端自身的浏览器访问首页查看抓取结果,因为爬虫是即时抓取,所以可能会抓取很多页面数据。

使用浏览器访问网站抓取页面通过设置登录名和密码,登录用户账号cookie和密码获取页面中抓取到的http请求的headers即可。下次我们会继续分享一些实战知识。

java爬虫抓取网页数据(Java网络爬虫系列文章之采集虎扑列表新闻(图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 113 次浏览 • 2022-04-10 03:01

这是Java网络爬虫系列的第一篇文章。如果您不了解Java网络爬虫系列文章,请参考学习Java网络爬虫所需的基础知识。第一篇是关于Java网络爬虫的介绍。在本文中,我们以 采集hupu 列表新闻的新闻标题和详情页为例。需要提取的内容如下图所示:

我们需要提取图中圈出的文字及其对应的链接。在提取过程中,我们会使用两种方法进行提取,一种是Jsoup方法,另一种是httpclient+正则表达式方法。它们也是Java网络爬虫常用的两种方法。这两种方法你不懂也没关系。后面会有相应的说明书。在正式写解压程序之前,先解释一下Java爬虫系列博文的环境。本系列博文中的所有demo都是使用SpringBoot搭建的。无论使用哪种环境,只需要正确导入对应的包即可。

通过 Jsoup 提取信息

我们先用Jsoup来提取新闻信息。如果你还不了解 Jsoup,请参考

首先创建一个Springboot项目,名称可选,在pom.xml中引入Jsoup的依赖

org.jsoup

jsoup

1.12.1

好,我们一起来分析一下页面,想必你还没有浏览过,点击这里浏览虎扑新闻。在列表页面中,我们使用F12评论元素查看页面结构,经过我们的分析,我们发现列表新闻在

标签下,每条新闻都是一个li标签,分析结果如下图所示:

既然我们已经知道了css选择器,我们结合浏览器的Copy功能,为我们的a标签编写了css选择器代码: div.news-list > ul > li > div.list-hd > h4 > a ,一切准备就绪,让我们编写Jsoup方式提取信息的代码:

/**

* jsoup方式 获取虎扑新闻列表页

* @param url 虎扑新闻列表页url

*/

public void jsoupList(String url){

try {

Document document = Jsoup.connect(url).get();

// 使用 css选择器 提取列表新闻 a 标签

// 霍华德:夏休期内曾节食30天,这考验了我的身心

Elements elements = document.select("div.news-list > ul > li > div.list-hd > h4 > a");

for (Element element:elements){

// System.out.println(element);

// 获取详情页链接

String d_url = element.attr("href");

// 获取标题

String title = element.ownText();

System.out.println("详情页链接:"+d_url+" ,详情页标题:"+title);

}

} catch (IOException e) {

e.printStackTrace();

}

}

使用Jsoup提取非常简单,只需5、6行代码即可完成。更多Jsoup如何提取节点信息,请参考jsoup官网教程。我们编写main方法执行jsoupList方法,看看jsoupList方法是否正确。

public static void main(String[] args) {

String url = "https://voice.hupu.com/nba";

CrawlerBase crawlerBase = new CrawlerBase();

crawlerBase.jsoupList(url);

}

执行main方法,得到如下结果:

从结果可以看出,我们已经正确地提取到了我们想要的信息。如果要采集详情页的信息,只需要写一个采集详情页的方法,在方法中提取详情页对应的节点信息,然后通过将列表页面中的链接提取到详细信息页面的提取方法中。 查看全部

java爬虫抓取网页数据(Java网络爬虫系列文章之采集虎扑列表新闻(图))

这是Java网络爬虫系列的第一篇文章。如果您不了解Java网络爬虫系列文章,请参考学习Java网络爬虫所需的基础知识。第一篇是关于Java网络爬虫的介绍。在本文中,我们以 采集hupu 列表新闻的新闻标题和详情页为例。需要提取的内容如下图所示:

我们需要提取图中圈出的文字及其对应的链接。在提取过程中,我们会使用两种方法进行提取,一种是Jsoup方法,另一种是httpclient+正则表达式方法。它们也是Java网络爬虫常用的两种方法。这两种方法你不懂也没关系。后面会有相应的说明书。在正式写解压程序之前,先解释一下Java爬虫系列博文的环境。本系列博文中的所有demo都是使用SpringBoot搭建的。无论使用哪种环境,只需要正确导入对应的包即可。

通过 Jsoup 提取信息

我们先用Jsoup来提取新闻信息。如果你还不了解 Jsoup,请参考

首先创建一个Springboot项目,名称可选,在pom.xml中引入Jsoup的依赖

org.jsoup

jsoup

1.12.1

好,我们一起来分析一下页面,想必你还没有浏览过,点击这里浏览虎扑新闻。在列表页面中,我们使用F12评论元素查看页面结构,经过我们的分析,我们发现列表新闻在

标签下,每条新闻都是一个li标签,分析结果如下图所示:

既然我们已经知道了css选择器,我们结合浏览器的Copy功能,为我们的a标签编写了css选择器代码: div.news-list > ul > li > div.list-hd > h4 > a ,一切准备就绪,让我们编写Jsoup方式提取信息的代码:

/**

* jsoup方式 获取虎扑新闻列表页

* @param url 虎扑新闻列表页url

*/

public void jsoupList(String url){

try {

Document document = Jsoup.connect(url).get();

// 使用 css选择器 提取列表新闻 a 标签

// 霍华德:夏休期内曾节食30天,这考验了我的身心

Elements elements = document.select("div.news-list > ul > li > div.list-hd > h4 > a");

for (Element element:elements){

// System.out.println(element);

// 获取详情页链接

String d_url = element.attr("href");

// 获取标题

String title = element.ownText();

System.out.println("详情页链接:"+d_url+" ,详情页标题:"+title);

}

} catch (IOException e) {

e.printStackTrace();

}

}

使用Jsoup提取非常简单,只需5、6行代码即可完成。更多Jsoup如何提取节点信息,请参考jsoup官网教程。我们编写main方法执行jsoupList方法,看看jsoupList方法是否正确。

public static void main(String[] args) {

String url = "https://voice.hupu.com/nba";

CrawlerBase crawlerBase = new CrawlerBase();

crawlerBase.jsoupList(url);

}

执行main方法,得到如下结果:

从结果可以看出,我们已经正确地提取到了我们想要的信息。如果要采集详情页的信息,只需要写一个采集详情页的方法,在方法中提取详情页对应的节点信息,然后通过将列表页面中的链接提取到详细信息页面的提取方法中。

java爬虫抓取网页数据(架构架构组成URL管理器存储方式存储 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 199 次浏览 • 2022-04-09 01:35

)

1、抓取网页本身的接口

相比其他静态编程语言,如java、c#、c++、python,爬取网页文档的界面更加简洁;与 perl、shell 等其他动态脚本语言相比,python 的 urllib 包提供了对 web 文档的更完整的访问。API。(当然红宝石也是不错的选择)

另外,爬取网页有时需要模拟浏览器的行为,很多网站被屏蔽用于生硬的爬虫爬取。这就是我们需要模拟用户代理的行为来构造适当请求的地方,例如模拟用户登录、模拟会话/cookie存储和设置。python中有非常好的第三方包可以帮助你,比如Requests,mechanize

2、网页抓取后的处理

抓取的网页通常需要进行处理,比如过滤html标签、提取文本等。Python的beautifulsoap提供了简洁的文档处理功能,可以用极短的代码完成大部分文档处理。

其实很多语言和工具都可以做到以上功能,但是python可以做到最快最干净。

人生苦短,你需要python。

PS:python2.x 和 python3.x 很不一样。本文只讨论python3.x的爬虫实现方法。

爬虫架构的组成

URL管理器:管理待爬取的url集合和已爬取的url集合,并将待爬取的url发送给网页下载器。

网页下载器(urllib):抓取url对应的网页,存储为字符串,发送给网页解析器。

网页解析器(BeautifulSoup):解析出有价值的数据,存储起来,补充url给URL管理器。

运行进程

URL管理器基本功能存储方法

1、内存(python内存)

要爬取的url集合:set()

抓取的url集合:set()

2、关系型数据库(mysql)

网址(网址,is_crawled)

3、缓存(redis)

要爬取的url集合:set

爬取的 url 集合:set

由于缓存数据库的高性能,大型互联网公司一般将 URL 存储在缓存数据库中。小公司一般将 URL 存储在内存中,如果要永久存储,请将其存储在关系数据库中。

网页下载器 (urllib)

将url对应的网页下载到本地,保存为文件或字符串。

基本方法

新建一个baidu.py,内容如下:

import urllib.request

response = urllib.request.urlopen('http://www.baidu.com')

buff = response.read()

html = buff.decode("utf8")

print(html)

在命令行执行python baidu.py,打印出得到的页面。

构造请求

上面的代码可以修改为:

import urllib.request

request = urllib.request.Request('http://www.baidu.com')

response = urllib.request.urlopen(request)

buff = response.read()

html = buff.decode("utf8")

print(html)

携带参数

新建一个baidu2.py,内容如下:

import urllib.request

import urllib.parse

url = 'http://www.baidu.com'

values = {'name': 'voidking','language': 'Python'}

data = urllib.parse.urlencode(values).encode(encoding='utf-8',errors='ignore')

headers = { 'User-Agent' : 'Mozilla/5.0 (Windows NT 10.0; WOW64; rv:50.0) Gecko/20100101 Firefox/50.0' }

request = urllib.request.Request(url=url, data=data,headers=headers,method='GET')

response = urllib.request.urlopen(request)

buff = response.read()

html = buff.decode("utf8")

print(html)

使用 Fiddler 监听数据

我们想看看我们的请求是否真的携带参数,所以我们需要使用fiddler。

打开fiddler后,无意中发现上面的代码会报错504,不管是baidu.py还是baidu2.py。

虽然python报错,但是在fiddler中,我们可以看到请求信息,里面确实携带了参数。

查资料发现以前的python版本不支持代理环境下访问https。但是,最新版本应该支持它。那么,最简单的方法就是更改使用http协议进行爬取的url,例如,将其替换为 . 结果还是报错,但是变成了400错误。

然而,然而,然而。. . 神的转折点出现了!!!

当我将url替换为时,请求成功!没错,只需在 URL 后加一个额外的斜杠 / 即可。同理,改成,请求也成功了!魔法!!!

添加处理器

import urllib.request

import http.cookiejar

# 创建cookie容器

cj = http.cookiejar.CookieJar()

# 创建opener

opener = urllib.request.build_opener(urllib.request.HTTPCookieProcessor(cj))

# 给urllib.request安装opener

urllib.request.install_opener(opener)

# 请求

request = urllib.request.Request('http://www.baidu.com/')

response = urllib.request.urlopen(request)

buff = response.read()

html = buff.decode("utf8")

print(html)

print(cj)

Web 解析器 (BeautifulSoup)

从网页中提取有价值的数据和新的 url 列表。

解析器选择

为了实现解析器,可以选择使用正则表达式、html.parser、BeautifulSoup、lxml等,这里我们选择BeautifulSoup。

其中,正则表达式基于模糊匹配,而其他三个基于DOM结构化解析。

BeautifulSoup 安装测试

1、要安装,在命令行执行pip install beautifulsoup4。

2、测试

import bs4

print(bs4)

使用说明

基本用法

1、创建 BeautifulSoup 对象

import bs4

from bs4 import BeautifulSoup

# 根据html网页字符串创建BeautifulSoup对象

html_doc = """

The Dormouse's story

<p class="title">The Dormouse's story

Once upon a time there were three little sisters; and their names were

Elsie,

Lacie and

Tillie;

and they lived at the bottom of a well.

...

"""

soup = BeautifulSoup(html_doc)

print(soup.prettify())</p>

2、访问节点

print(soup.title)

print(soup.title.name)

print(soup.title.string)

print(soup.title.parent.name)

print(soup.p)

print(soup.p['class'])

3、指定标签、类或id

print(soup.find_all('a'))

print(soup.find('a'))

print(soup.find(class_='title'))

print(soup.find(id="link3"))

print(soup.find('p',class_='title'))

4、从文档中找到所有标签的链接

for link in soup.find_all('a'):

print(link.get('href'))

出现了警告。根据提示,我们可以在创建 BeautifulSoup 对象时指定解析器。

soup = BeautifulSoup(html_doc,'html.parser')

5、从文档中获取所有文本内容

print(soup.get_text())

6、常规赛

link_node = soup.find('a',href=re.compile(r"til"))

print(link_node) 查看全部

java爬虫抓取网页数据(架构架构组成URL管理器存储方式存储

)

1、抓取网页本身的接口

相比其他静态编程语言,如java、c#、c++、python,爬取网页文档的界面更加简洁;与 perl、shell 等其他动态脚本语言相比,python 的 urllib 包提供了对 web 文档的更完整的访问。API。(当然红宝石也是不错的选择)

另外,爬取网页有时需要模拟浏览器的行为,很多网站被屏蔽用于生硬的爬虫爬取。这就是我们需要模拟用户代理的行为来构造适当请求的地方,例如模拟用户登录、模拟会话/cookie存储和设置。python中有非常好的第三方包可以帮助你,比如Requests,mechanize

2、网页抓取后的处理

抓取的网页通常需要进行处理,比如过滤html标签、提取文本等。Python的beautifulsoap提供了简洁的文档处理功能,可以用极短的代码完成大部分文档处理。

其实很多语言和工具都可以做到以上功能,但是python可以做到最快最干净。

人生苦短,你需要python。

PS:python2.x 和 python3.x 很不一样。本文只讨论python3.x的爬虫实现方法。

爬虫架构的组成

URL管理器:管理待爬取的url集合和已爬取的url集合,并将待爬取的url发送给网页下载器。

网页下载器(urllib):抓取url对应的网页,存储为字符串,发送给网页解析器。

网页解析器(BeautifulSoup):解析出有价值的数据,存储起来,补充url给URL管理器。

运行进程

URL管理器基本功能存储方法

1、内存(python内存)

要爬取的url集合:set()

抓取的url集合:set()

2、关系型数据库(mysql)

网址(网址,is_crawled)

3、缓存(redis)

要爬取的url集合:set

爬取的 url 集合:set

由于缓存数据库的高性能,大型互联网公司一般将 URL 存储在缓存数据库中。小公司一般将 URL 存储在内存中,如果要永久存储,请将其存储在关系数据库中。

网页下载器 (urllib)

将url对应的网页下载到本地,保存为文件或字符串。

基本方法

新建一个baidu.py,内容如下:

import urllib.request

response = urllib.request.urlopen('http://www.baidu.com')

buff = response.read()

html = buff.decode("utf8")

print(html)

在命令行执行python baidu.py,打印出得到的页面。

构造请求

上面的代码可以修改为:

import urllib.request

request = urllib.request.Request('http://www.baidu.com')

response = urllib.request.urlopen(request)

buff = response.read()

html = buff.decode("utf8")

print(html)

携带参数

新建一个baidu2.py,内容如下:

import urllib.request

import urllib.parse

url = 'http://www.baidu.com'

values = {'name': 'voidking','language': 'Python'}

data = urllib.parse.urlencode(values).encode(encoding='utf-8',errors='ignore')

headers = { 'User-Agent' : 'Mozilla/5.0 (Windows NT 10.0; WOW64; rv:50.0) Gecko/20100101 Firefox/50.0' }

request = urllib.request.Request(url=url, data=data,headers=headers,method='GET')

response = urllib.request.urlopen(request)

buff = response.read()

html = buff.decode("utf8")

print(html)

使用 Fiddler 监听数据

我们想看看我们的请求是否真的携带参数,所以我们需要使用fiddler。

打开fiddler后,无意中发现上面的代码会报错504,不管是baidu.py还是baidu2.py。

虽然python报错,但是在fiddler中,我们可以看到请求信息,里面确实携带了参数。

查资料发现以前的python版本不支持代理环境下访问https。但是,最新版本应该支持它。那么,最简单的方法就是更改使用http协议进行爬取的url,例如,将其替换为 . 结果还是报错,但是变成了400错误。

然而,然而,然而。. . 神的转折点出现了!!!

当我将url替换为时,请求成功!没错,只需在 URL 后加一个额外的斜杠 / 即可。同理,改成,请求也成功了!魔法!!!

添加处理器

import urllib.request

import http.cookiejar

# 创建cookie容器

cj = http.cookiejar.CookieJar()

# 创建opener

opener = urllib.request.build_opener(urllib.request.HTTPCookieProcessor(cj))

# 给urllib.request安装opener

urllib.request.install_opener(opener)

# 请求

request = urllib.request.Request('http://www.baidu.com/')

response = urllib.request.urlopen(request)

buff = response.read()

html = buff.decode("utf8")

print(html)

print(cj)

Web 解析器 (BeautifulSoup)

从网页中提取有价值的数据和新的 url 列表。

解析器选择

为了实现解析器,可以选择使用正则表达式、html.parser、BeautifulSoup、lxml等,这里我们选择BeautifulSoup。

其中,正则表达式基于模糊匹配,而其他三个基于DOM结构化解析。

BeautifulSoup 安装测试

1、要安装,在命令行执行pip install beautifulsoup4。

2、测试

import bs4

print(bs4)

使用说明

基本用法

1、创建 BeautifulSoup 对象

import bs4

from bs4 import BeautifulSoup

# 根据html网页字符串创建BeautifulSoup对象

html_doc = """

The Dormouse's story

<p class="title">The Dormouse's story

Once upon a time there were three little sisters; and their names were

Elsie,

Lacie and

Tillie;

and they lived at the bottom of a well.

...

"""

soup = BeautifulSoup(html_doc)

print(soup.prettify())</p>

2、访问节点

print(soup.title)

print(soup.title.name)

print(soup.title.string)

print(soup.title.parent.name)

print(soup.p)

print(soup.p['class'])

3、指定标签、类或id

print(soup.find_all('a'))

print(soup.find('a'))

print(soup.find(class_='title'))

print(soup.find(id="link3"))

print(soup.find('p',class_='title'))

4、从文档中找到所有标签的链接

for link in soup.find_all('a'):

print(link.get('href'))

出现了警告。根据提示,我们可以在创建 BeautifulSoup 对象时指定解析器。

soup = BeautifulSoup(html_doc,'html.parser')

5、从文档中获取所有文本内容

print(soup.get_text())

6、常规赛

link_node = soup.find('a',href=re.compile(r"til"))

print(link_node)

java爬虫抓取网页数据(一个Python多线程采集爬虫的具体操作流程及费用介绍)

网站优化 • 优采云 发表了文章 • 0 个评论 • 107 次浏览 • 2022-04-08 05:28

一个Python多线程爬虫,工作时打开10个线程爬取新浪网页的数据,爬取并保存页面,根据deep返回页面链接,根据key判断是否保存页面,其中:deep = 当=0时,为最后一次爬取深度,即只爬取并保存页面,当不分析链接时 deep > 0,返回页面链接。编写这个采集爬虫的具体要求:1.指定网站爬取指定深度的页面,并将收录指定关键词的页面内容存储在sqlite3数据库文件中< @2.程序每10秒在屏幕上打印一次进度信息3.支持线程池机制,同时抓取网页4.代码需要详细注释,需要深入理解各种程序涉及的程序类型知识点5.需要实现线程池功能说明用python写一个网站爬虫程序,支持的参数如下: spider.py -u url -d deep - f logfile -l loglevel(1-5) --testself -thread number --dbfile filepath --key="HTML5" 参数说明: -u 指定爬虫的起始地址 -d 指定爬虫的深度--thread 指定线程池大小,多线程爬取页面,可选参数,默认10--dbfile store th e 指定数据库(sqlite)文件中的结果数据 --关键词在关键页面,获取满足关键词的网页,可选参数,默认为所有页面 -l 日志文件记录详细信息,数字越大,记录越详细,可选参数,默认spider.log--testself程序自检,可选参数 查看全部

java爬虫抓取网页数据(一个Python多线程采集爬虫的具体操作流程及费用介绍)

一个Python多线程爬虫,工作时打开10个线程爬取新浪网页的数据,爬取并保存页面,根据deep返回页面链接,根据key判断是否保存页面,其中:deep = 当=0时,为最后一次爬取深度,即只爬取并保存页面,当不分析链接时 deep > 0,返回页面链接。编写这个采集爬虫的具体要求:1.指定网站爬取指定深度的页面,并将收录指定关键词的页面内容存储在sqlite3数据库文件中< @2.程序每10秒在屏幕上打印一次进度信息3.支持线程池机制,同时抓取网页4.代码需要详细注释,需要深入理解各种程序涉及的程序类型知识点5.需要实现线程池功能说明用python写一个网站爬虫程序,支持的参数如下: spider.py -u url -d deep - f logfile -l loglevel(1-5) --testself -thread number --dbfile filepath --key="HTML5" 参数说明: -u 指定爬虫的起始地址 -d 指定爬虫的深度--thread 指定线程池大小,多线程爬取页面,可选参数,默认10--dbfile store th e 指定数据库(sqlite)文件中的结果数据 --关键词在关键页面,获取满足关键词的网页,可选参数,默认为所有页面 -l 日志文件记录详细信息,数字越大,记录越详细,可选参数,默认spider.log--testself程序自检,可选参数

java爬虫抓取网页数据(2016年上海事业单位医疗招聘:现学现卖解析 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 78 次浏览 • 2022-04-07 04:15

)

故事的开始

虽然我们的程序员不做爬虫的工作,但是当我们工作中偶尔需要网络上的数据时,如果手动复制粘贴数据量少的话还是不错的。如果数据量很大,浪费时间真的很无聊。

所以现在我在学习,研究了一个多小时写一个爬虫程序

一、爬虫所需的工具包

新建一个Maven项目,导入爬虫工具包Jsoup

org.jsoup

jsoup

1.10.2

使用 Jsoup 解析网页

首先我们需要获取我们请求的网页的地址

使用Jsoup的parse()方法解析网页,传入两个参数,第一个参数是new URL(url),第二个参数设置解析时间超过30秒就放弃

然后得到一个 Document 对象

之后,就像我们操作 JS 代码一样,Document 对象可以实现 JS 的所有操作

这时候我们用浏览器打开网页,F12检查元素,找到数据所在的div的id名称。如果没有 id 名称,则使用 cals 名称。这里没有 id 名称。

然后我们通过类名获取元素。这时候我们可以输出 System.out.println(chinajobs); 看看我们是否得到了我们想要的数据。

可以看出确实得到了我们想要的数据

过滤数据

虽然得到了数据,但是有很多冗余信息,所以下一步就是对数据进行过滤

因为类不是唯一的,所以获取到 Elements 对象。在进行下一步之前,我们需要将其转换为 Element 对象。

Element el = chinajobs.first();

将chinajobs中的第一个元素转化为Element对象(首先确保我们需要的数据在chinajobs中的第一个元素中)

通过分析发现可以从title属性中提取出我们需要的数据

String title = el.getElementsByAttribute("title").text();

尝试输出

System.out.println(el.getElementsByAttribute("title").text());

过滤到我们想要的所有数据

四、导出到 Excel

最后一步是导出到excel,这里我使用的是poi工具包

org.apache.poi

poi

3.17

通过 el.getElementsByAttribute("title").size() 确定元素个数

循环输出

el.getElementsByAttribute("title").eq(i) 通过传入eq(i)的索引值确定元素值

D盘新建上海招聘公司名单.xls文件

<p>public static void main(String[] args) throws IOException {

// 获取请求 https://www.buildhr.com/area/shanghai/

String url = "https://www.buildhr.com/area/shanghai/";

Document document = Jsoup.parse(new URL(url), 30000);

Elements chinajobs = document.getElementsByClass("chinajobs");

HSSFWorkbook wb = new HSSFWorkbook();

HSSFSheet sheet = wb.createSheet("公司名列表");

Element el = chinajobs.first();

for (int i = 0; i 查看全部

java爬虫抓取网页数据(2016年上海事业单位医疗招聘:现学现卖解析

)

故事的开始

虽然我们的程序员不做爬虫的工作,但是当我们工作中偶尔需要网络上的数据时,如果手动复制粘贴数据量少的话还是不错的。如果数据量很大,浪费时间真的很无聊。

所以现在我在学习,研究了一个多小时写一个爬虫程序

一、爬虫所需的工具包

新建一个Maven项目,导入爬虫工具包Jsoup

org.jsoup

jsoup

1.10.2

使用 Jsoup 解析网页

首先我们需要获取我们请求的网页的地址

使用Jsoup的parse()方法解析网页,传入两个参数,第一个参数是new URL(url),第二个参数设置解析时间超过30秒就放弃

然后得到一个 Document 对象

之后,就像我们操作 JS 代码一样,Document 对象可以实现 JS 的所有操作

这时候我们用浏览器打开网页,F12检查元素,找到数据所在的div的id名称。如果没有 id 名称,则使用 cals 名称。这里没有 id 名称。

然后我们通过类名获取元素。这时候我们可以输出 System.out.println(chinajobs); 看看我们是否得到了我们想要的数据。

可以看出确实得到了我们想要的数据

过滤数据

虽然得到了数据,但是有很多冗余信息,所以下一步就是对数据进行过滤

因为类不是唯一的,所以获取到 Elements 对象。在进行下一步之前,我们需要将其转换为 Element 对象。

Element el = chinajobs.first();

将chinajobs中的第一个元素转化为Element对象(首先确保我们需要的数据在chinajobs中的第一个元素中)

通过分析发现可以从title属性中提取出我们需要的数据

String title = el.getElementsByAttribute("title").text();

尝试输出

System.out.println(el.getElementsByAttribute("title").text());

过滤到我们想要的所有数据

四、导出到 Excel

最后一步是导出到excel,这里我使用的是poi工具包

org.apache.poi

poi

3.17

通过 el.getElementsByAttribute("title").size() 确定元素个数

循环输出

el.getElementsByAttribute("title").eq(i) 通过传入eq(i)的索引值确定元素值

D盘新建上海招聘公司名单.xls文件

<p>public static void main(String[] args) throws IOException {

// 获取请求 https://www.buildhr.com/area/shanghai/

String url = "https://www.buildhr.com/area/shanghai/";

Document document = Jsoup.parse(new URL(url), 30000);

Elements chinajobs = document.getElementsByClass("chinajobs");

HSSFWorkbook wb = new HSSFWorkbook();

HSSFSheet sheet = wb.createSheet("公司名列表");

Element el = chinajobs.first();

for (int i = 0; i

java爬虫抓取网页数据(就用find_find)

网站优化 • 优采云 发表了文章 • 0 个评论 • 67 次浏览 • 2022-04-06 15:17

每个div都会有一个h2,里面有一个a,a里面收录我们想要的title名称。所以我们使用find_all来查找所有这样的div标签,将它们存储为一个列表,然后循环遍历列表,为每个元素提取h2a,然后提取标签的内容。

当然我们也可以找到_all最外层的li标签,然后逐层查找,都是一样的。只需找到定位信息的唯一标识符(标签或属性)即可。

虽然看这里的源码可以折叠一些无用的代码,但其实还有一些更好的工具可以帮助我们在网页的源码中找到我们想要的信息的位置。例如,下面的鼠标符号。

当所有代码折叠后,点击鼠标,然后点击网页中的元素,浏览器会自动为你选择你点击的元素。事实上,当你将鼠标悬停在一个元素上时,它已经帮你定位到它了,如下图所示

总结

当我们要爬取一个网页时,只需要下面的过程

现在,我们可以处理一些网站,无需任何反爬措施。至于如何组织多个字段的数据,如何设计爬取多个页面的代码(在常规URL的情况下),不是爬虫知识的范畴,可以用python的基础知识来解决。文章 的下一个系列将重点介绍这部分。接下来给几个目前可以练手的网站

如果您在使用 BeautifulSoup 的定位过程中遇到困难,可以直接在网上搜索教程,也可以等待本主题后面更新的 BeautifulSoup 详细介绍。

如果你去爬其他的网站,最好检查一下r.text是否和网站的源码一模一样,如果不是,说明你的其他服务器做了不给你真实信息,说明他可能看出你是爬虫(做网页请求时,浏览器和requests.get相当于拿着一堆资质证书敲门,对方会查你的资质证书,而浏览器的资质证书一般是可以通过的,但是代码的资质证书可能不合格,因为代码的资质证书可能有一些比较固定的特性,这就是反爬机制)。这时候就需要了解一些反反爬的措施,才能获取真实的信息。 查看全部

java爬虫抓取网页数据(就用find_find)

每个div都会有一个h2,里面有一个a,a里面收录我们想要的title名称。所以我们使用find_all来查找所有这样的div标签,将它们存储为一个列表,然后循环遍历列表,为每个元素提取h2a,然后提取标签的内容。

当然我们也可以找到_all最外层的li标签,然后逐层查找,都是一样的。只需找到定位信息的唯一标识符(标签或属性)即可。

虽然看这里的源码可以折叠一些无用的代码,但其实还有一些更好的工具可以帮助我们在网页的源码中找到我们想要的信息的位置。例如,下面的鼠标符号。

当所有代码折叠后,点击鼠标,然后点击网页中的元素,浏览器会自动为你选择你点击的元素。事实上,当你将鼠标悬停在一个元素上时,它已经帮你定位到它了,如下图所示

总结

当我们要爬取一个网页时,只需要下面的过程

现在,我们可以处理一些网站,无需任何反爬措施。至于如何组织多个字段的数据,如何设计爬取多个页面的代码(在常规URL的情况下),不是爬虫知识的范畴,可以用python的基础知识来解决。文章 的下一个系列将重点介绍这部分。接下来给几个目前可以练手的网站

如果您在使用 BeautifulSoup 的定位过程中遇到困难,可以直接在网上搜索教程,也可以等待本主题后面更新的 BeautifulSoup 详细介绍。

如果你去爬其他的网站,最好检查一下r.text是否和网站的源码一模一样,如果不是,说明你的其他服务器做了不给你真实信息,说明他可能看出你是爬虫(做网页请求时,浏览器和requests.get相当于拿着一堆资质证书敲门,对方会查你的资质证书,而浏览器的资质证书一般是可以通过的,但是代码的资质证书可能不合格,因为代码的资质证书可能有一些比较固定的特性,这就是反爬机制)。这时候就需要了解一些反反爬的措施,才能获取真实的信息。

java爬虫抓取网页数据(网络爬虫(又被称为网页蜘蛛,网络机器人() )

网站优化 • 优采云 发表了文章 • 0 个评论 • 54 次浏览 • 2022-04-06 04:03

)

网络爬虫

网络爬虫(也称为网络蜘蛛、网络机器人,在 FOAF 社区中更常称为网络追逐者)是根据一定规则自动从万维网上爬取信息的程序或脚本。

其他不太常用的名称是 ant、autoindex、emulator 或 worm。网络蜘蛛通过网页的链接地址搜索网页,从网站的某个页面(通常是首页)开始,阅读

网页的内容,找到网页中的其他链接地址,然后通过这些链接地址寻找下一个网页,如此循环下去,直到这个网站的所有网页都被爬取完毕。如果整个

互联网被视为一个网站,那么网络蜘蛛就可以利用这个原理爬取互联网上的所有网页。因此,为了抓取网络上的数据,不仅需要爬虫,还需要

接收“爬虫”发送的数据并进行处理和过滤的服务器。爬虫爬取的数据量越大,对服务器的性能要求就越高。

1 重点介绍爬虫的工作原理及关键技术概述

网络爬虫是一种自动提取网页的程序。它为搜索引擎从万维网上下载网页,是搜索引擎的重要组成部分。传统爬虫从一个或多个初始网页的URL开始,获取初始网页的信息。

在抓取网页的过程中,不断地从当前页面中提取新的 URL 并放入队列中,直到满足系统的某些停止条件。焦点爬虫的工作流程比较复杂,需要根据某个网页进行分析

算法过滤掉主题链接,保留有用的链接并将它们放入等待抓取的 URL 队列中。然后,它会根据一定的搜索策略从队列中选择下一个要爬取的网页URL,重复上述操作

停止上述过程,直到达到系统的某个条件。此外,所有被爬虫爬取的网页都会被系统存储,经过一定的分析、过滤、索引,以供后续查询和检索;

对于焦爬虫来说,这个过程中得到的分析结果也可能对后续的爬取过程起到反馈和指导作用。

与通用网络爬虫相比,聚焦爬虫还需要解决三个主要问题:

(1) 获取目标的描述或定义;

(2) 网页或数据的分析和过滤;

(3) URL 的搜索策略。

分类

根据系统结构和实现技术,网络爬虫大致可以分为以下几种:通用网络爬虫、重点网络爬虫、

增量网络爬虫,深度网络爬虫。实际的网络爬虫系统通常是通过结合几种爬虫技术来实现的。

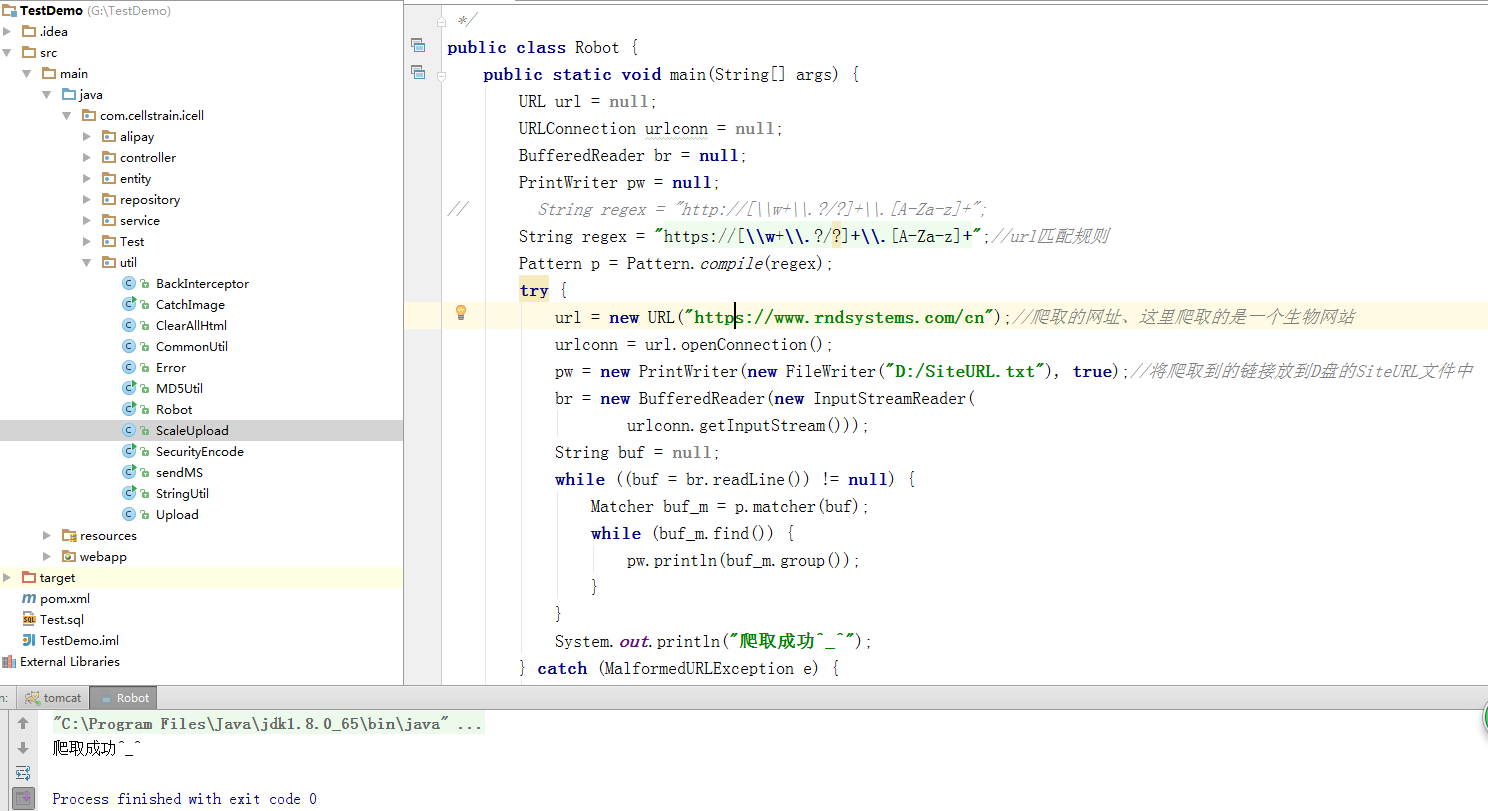

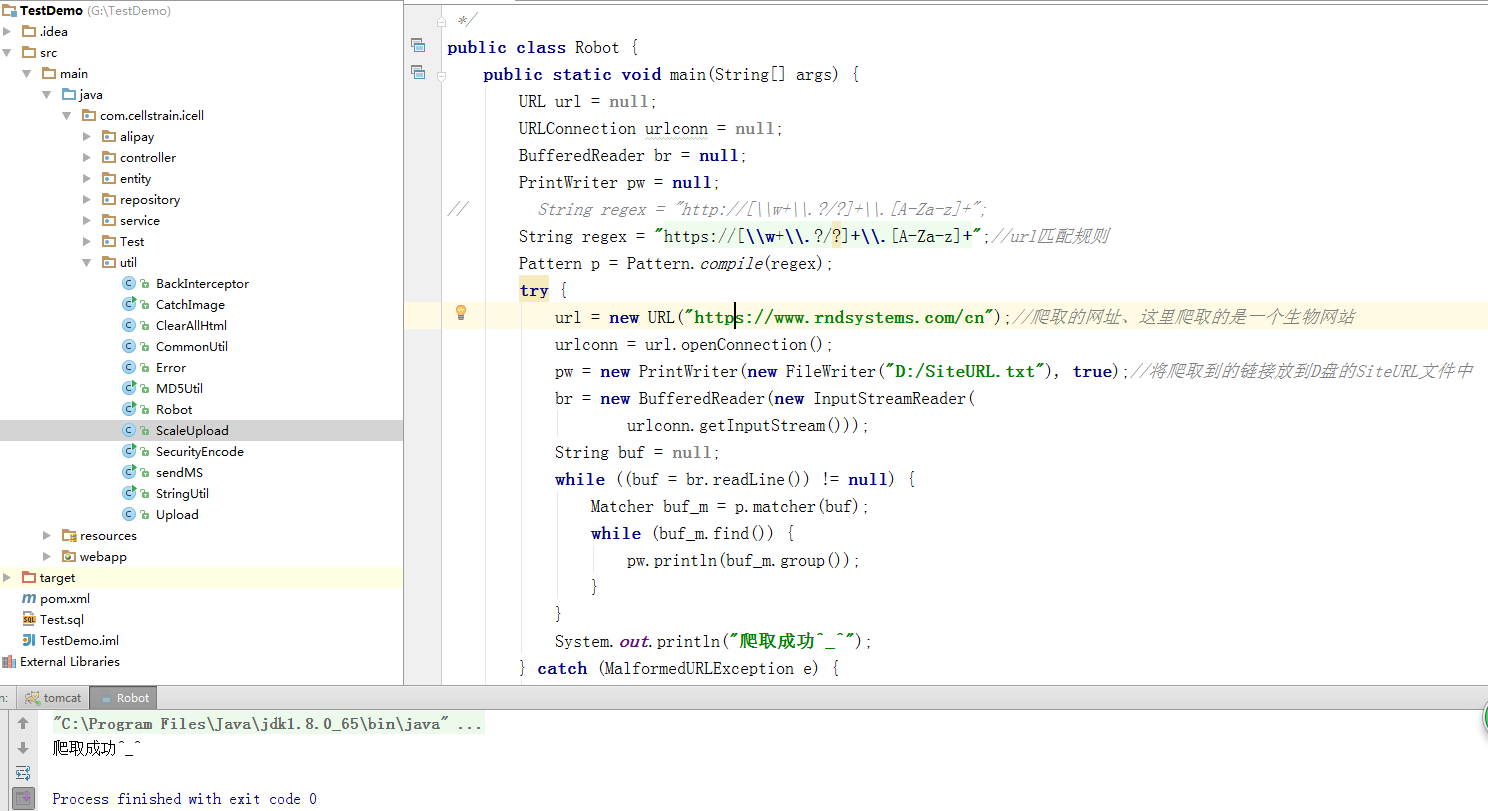

网络爬虫实现原理

根据这个原理,编写一个简单的网络爬虫程序,这个程序的作用是获取网站发回的数据,并提取其中的URL。我们将获取的 URL 存储在一个文件夹中。刚从网上

网站获取的URL进一步循环获取数据,提取其他数据。这里就不写了,只是模拟一个最简单的原理。实际的网站爬虫远比这个复杂,深入的讨论太多了。

. 除了提取URL之外,我们还可以提取我们想要的各种其他信息,只要我们修改过滤数据的表达式即可。下面是一个Java模拟的提取新浪网页链接并存储的程序

在一个文件中

源代码如下

package com.cellstrain.icell.util;<br /><br />import java.io.*;<br />import java.net.*;<br />import java.util.regex.Matcher;<br />import java.util.regex.Pattern;<br /><br />/**<br /> * java实现爬虫<br /> */<br />public class Robot {<br /> public static void main(String[] args) {<br /> URL url = null;<br /> URLConnection urlconn = null;<br /> BufferedReader br = null;<br /> PrintWriter pw = null;<br />// String regex = "http://[\\w+\\.?/?]+\\.[A-Za-z]+";<br /> String regex = "https://[\\w+\\.?/?]+\\.[A-Za-z]+";//url匹配规则<br /> Pattern p = Pattern.compile(regex);<br /> try {<br /> url = new URL("https://www.rndsystems.com/cn");//爬取的网址、这里爬取的是一个生物网站<br /> urlconn = url.openConnection();<br /> pw = new PrintWriter(new FileWriter("D:/SiteURL.txt"), true);//将爬取到的链接放到D盘的SiteURL文件中<br /> br = new BufferedReader(new InputStreamReader(<br /> urlconn.getInputStream()));<br /> String buf = null;<br /> while ((buf = br.readLine()) != null) {<br /> Matcher buf_m = p.matcher(buf);<br /> while (buf_m.find()) {<br /> pw.println(buf_m.group());<br /> }<br /> }<br /> System.out.println("爬取成功^_^");<br /> } catch (MalformedURLException e) {<br /> e.printStackTrace();<br /> } catch (IOException e) {<br /> e.printStackTrace();<br /> } finally {<br /> try {<br /> br.close();<br /> } catch (IOException e) {<br /> e.printStackTrace();<br /> }<br /> pw.close();<br /> }<br /> }<br />}<br />

运行idea的结果如下:

检查D盘是否有SiteURL.txt文件

已经成功生成SiteURL文件,打开就可以看到所有抓到的url

查看全部

java爬虫抓取网页数据(网络爬虫(又被称为网页蜘蛛,网络机器人()

)

网络爬虫

网络爬虫(也称为网络蜘蛛、网络机器人,在 FOAF 社区中更常称为网络追逐者)是根据一定规则自动从万维网上爬取信息的程序或脚本。

其他不太常用的名称是 ant、autoindex、emulator 或 worm。网络蜘蛛通过网页的链接地址搜索网页,从网站的某个页面(通常是首页)开始,阅读

网页的内容,找到网页中的其他链接地址,然后通过这些链接地址寻找下一个网页,如此循环下去,直到这个网站的所有网页都被爬取完毕。如果整个

互联网被视为一个网站,那么网络蜘蛛就可以利用这个原理爬取互联网上的所有网页。因此,为了抓取网络上的数据,不仅需要爬虫,还需要

接收“爬虫”发送的数据并进行处理和过滤的服务器。爬虫爬取的数据量越大,对服务器的性能要求就越高。

1 重点介绍爬虫的工作原理及关键技术概述

网络爬虫是一种自动提取网页的程序。它为搜索引擎从万维网上下载网页,是搜索引擎的重要组成部分。传统爬虫从一个或多个初始网页的URL开始,获取初始网页的信息。

在抓取网页的过程中,不断地从当前页面中提取新的 URL 并放入队列中,直到满足系统的某些停止条件。焦点爬虫的工作流程比较复杂,需要根据某个网页进行分析

算法过滤掉主题链接,保留有用的链接并将它们放入等待抓取的 URL 队列中。然后,它会根据一定的搜索策略从队列中选择下一个要爬取的网页URL,重复上述操作

停止上述过程,直到达到系统的某个条件。此外,所有被爬虫爬取的网页都会被系统存储,经过一定的分析、过滤、索引,以供后续查询和检索;

对于焦爬虫来说,这个过程中得到的分析结果也可能对后续的爬取过程起到反馈和指导作用。

与通用网络爬虫相比,聚焦爬虫还需要解决三个主要问题:

(1) 获取目标的描述或定义;

(2) 网页或数据的分析和过滤;

(3) URL 的搜索策略。

分类

根据系统结构和实现技术,网络爬虫大致可以分为以下几种:通用网络爬虫、重点网络爬虫、

增量网络爬虫,深度网络爬虫。实际的网络爬虫系统通常是通过结合几种爬虫技术来实现的。

网络爬虫实现原理

根据这个原理,编写一个简单的网络爬虫程序,这个程序的作用是获取网站发回的数据,并提取其中的URL。我们将获取的 URL 存储在一个文件夹中。刚从网上

网站获取的URL进一步循环获取数据,提取其他数据。这里就不写了,只是模拟一个最简单的原理。实际的网站爬虫远比这个复杂,深入的讨论太多了。

. 除了提取URL之外,我们还可以提取我们想要的各种其他信息,只要我们修改过滤数据的表达式即可。下面是一个Java模拟的提取新浪网页链接并存储的程序

在一个文件中

源代码如下

package com.cellstrain.icell.util;<br /><br />import java.io.*;<br />import java.net.*;<br />import java.util.regex.Matcher;<br />import java.util.regex.Pattern;<br /><br />/**<br /> * java实现爬虫<br /> */<br />public class Robot {<br /> public static void main(String[] args) {<br /> URL url = null;<br /> URLConnection urlconn = null;<br /> BufferedReader br = null;<br /> PrintWriter pw = null;<br />// String regex = "http://[\\w+\\.?/?]+\\.[A-Za-z]+";<br /> String regex = "https://[\\w+\\.?/?]+\\.[A-Za-z]+";//url匹配规则<br /> Pattern p = Pattern.compile(regex);<br /> try {<br /> url = new URL("https://www.rndsystems.com/cn";);//爬取的网址、这里爬取的是一个生物网站<br /> urlconn = url.openConnection();<br /> pw = new PrintWriter(new FileWriter("D:/SiteURL.txt"), true);//将爬取到的链接放到D盘的SiteURL文件中<br /> br = new BufferedReader(new InputStreamReader(<br /> urlconn.getInputStream()));<br /> String buf = null;<br /> while ((buf = br.readLine()) != null) {<br /> Matcher buf_m = p.matcher(buf);<br /> while (buf_m.find()) {<br /> pw.println(buf_m.group());<br /> }<br /> }<br /> System.out.println("爬取成功^_^");<br /> } catch (MalformedURLException e) {<br /> e.printStackTrace();<br /> } catch (IOException e) {<br /> e.printStackTrace();<br /> } finally {<br /> try {<br /> br.close();<br /> } catch (IOException e) {<br /> e.printStackTrace();<br /> }<br /> pw.close();<br /> }<br /> }<br />}<br />

运行idea的结果如下:

检查D盘是否有SiteURL.txt文件

已经成功生成SiteURL文件,打开就可以看到所有抓到的url

java爬虫抓取网页数据(爬虫入门程序urllib2实现下载网页的三种方式:入门 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 70 次浏览 • 2022-04-04 02:10

)

爬虫入口程序

urllib2实现了三种下载网页的方式:

第一个:

import cookielib

import urllib2

url = "http://www.baidu.com"

response1 = urllib2.urlopen(url)

print "第一种方法"

#获取状态码,200表示成功

print response1.getcode()

#获取网页内容的长度

print len(response1.read())

第二:

request = urllib2.Request(url)

#模拟Mozilla浏览器进行爬虫

request.add_header("user-agent","Mozilla/5.0")

response2 = urllib2.urlopen(request)

print response2.getcode()

print len(response2.read())

第三:

cookie = cookielib.CookieJar()

#加入urllib2处理cookie的能力

opener = urllib2.build_opener(urllib2.HTTPCookieProcessor(cookie))

urllib2.install_opener(opener)

response3 = urllib2.urlopen(url)

print response3.getcode()

print len(response3.read())

print cookie

爬虫添加数据、标头,然后发布请求

import urllib

import urllib2

url = 'http://www.server.com/login'

user_agent = 'Mozilla/4.0 (compatible; MSIE 5.5; Windows NT)'

values = {'username' : 'cqc', 'password' : 'XXXX' }

headers = { 'User-Agent' : user_agent }

data = urllib.urlencode(values)

request = urllib2.Request(url, data, headers)

response = urllib2.urlopen(request)

page = response.read()

爬虫添加 cookie

为什么要添加 cookie?

Cookie,是指存储在用户本地终端上的一些网站数据(通常是加密的),用于识别用户身份和进行会话跟踪。比如有些网站需要登录才能访问某个页面,在登录之前,你想抓取一个页面内容是不允许的。然后我们就可以使用Urllib2库来保存我们登录的cookies,然后爬取其他页面来达到目的

获取 cookie 并将其保存到变量中

首先我们用CookieJar对象来实现获取cookies的功能,存储在变量中,先体验一下

import urllib2

import cookielib

#声明一个CookieJar对象实例来保存cookie

cookie = cookielib.CookieJar()

#利用urllib2库的HTTPCookieProcessor对象来创建cookie处理器

handler=urllib2.HTTPCookieProcessor(cookie)

#通过handler来构建opener

opener = urllib2.build_opener(handler)

#此处的open方法同urllib2的urlopen方法,也可以传入request

response = opener.open('http://www.baidu.com')

for item in cookie:

print 'Name = '+item.name

print 'Value = '+item.value

我们用上面的方法将cookie保存到一个变量中,然后打印出cookie中的值,结果如下

Name = BAIDUID

Value = B07B663B645729F11F659C02AAE65B4C:FG=1

Name = BAIDUPSID

Value = B07B663B645729F11F659C02AAE65B4C

Name = H_PS_PSSID

Value = 12527_11076_1438_10633

Name = BDSVRTM

Value = 0

Name = BD_HOME

Value = 0

将 cookie 保存到文件

在上述方法中,我们将cookie保存到cookie变量中。如果我们想将 cookie 保存到文件中怎么办?这时候,我们将使用 FileCookieJar 对象,这里我们使用它的子类 MozillaCookieJar 来保存 cookie

mport cookielib

import urllib2

#设置保存cookie的文件,同级目录下的cookie.txt

filename = 'cookie.txt'

#声明一个MozillaCookieJar对象实例来保存cookie,之后写入文件

cookie = cookielib.MozillaCookieJar(filename)

#利用urllib2库的HTTPCookieProcessor对象来创建cookie处理器

handler = urllib2.HTTPCookieProcessor(cookie)

#通过handler来构建opener

opener = urllib2.build_opener(handler)

#创建一个请求,原理同urllib2的urlopen

response = opener.open("http://www.baidu.com")

#保存cookie到文件

cookie.save(ignore_discard=True, ignore_expires=True)

正则表达式的正则表达式语法规则

查看全部

java爬虫抓取网页数据(爬虫入门程序urllib2实现下载网页的三种方式:入门

)

爬虫入口程序

urllib2实现了三种下载网页的方式:

第一个:

import cookielib

import urllib2

url = "http://www.baidu.com"

response1 = urllib2.urlopen(url)

print "第一种方法"

#获取状态码,200表示成功

print response1.getcode()

#获取网页内容的长度

print len(response1.read())

第二:

request = urllib2.Request(url)

#模拟Mozilla浏览器进行爬虫

request.add_header("user-agent","Mozilla/5.0")

response2 = urllib2.urlopen(request)

print response2.getcode()

print len(response2.read())

第三:

cookie = cookielib.CookieJar()

#加入urllib2处理cookie的能力

opener = urllib2.build_opener(urllib2.HTTPCookieProcessor(cookie))

urllib2.install_opener(opener)

response3 = urllib2.urlopen(url)

print response3.getcode()

print len(response3.read())

print cookie

爬虫添加数据、标头,然后发布请求

import urllib

import urllib2

url = 'http://www.server.com/login'

user_agent = 'Mozilla/4.0 (compatible; MSIE 5.5; Windows NT)'

values = {'username' : 'cqc', 'password' : 'XXXX' }

headers = { 'User-Agent' : user_agent }

data = urllib.urlencode(values)

request = urllib2.Request(url, data, headers)

response = urllib2.urlopen(request)

page = response.read()

爬虫添加 cookie

为什么要添加 cookie?

Cookie,是指存储在用户本地终端上的一些网站数据(通常是加密的),用于识别用户身份和进行会话跟踪。比如有些网站需要登录才能访问某个页面,在登录之前,你想抓取一个页面内容是不允许的。然后我们就可以使用Urllib2库来保存我们登录的cookies,然后爬取其他页面来达到目的

获取 cookie 并将其保存到变量中

首先我们用CookieJar对象来实现获取cookies的功能,存储在变量中,先体验一下

import urllib2

import cookielib

#声明一个CookieJar对象实例来保存cookie

cookie = cookielib.CookieJar()

#利用urllib2库的HTTPCookieProcessor对象来创建cookie处理器

handler=urllib2.HTTPCookieProcessor(cookie)

#通过handler来构建opener

opener = urllib2.build_opener(handler)

#此处的open方法同urllib2的urlopen方法,也可以传入request

response = opener.open('http://www.baidu.com')

for item in cookie:

print 'Name = '+item.name

print 'Value = '+item.value

我们用上面的方法将cookie保存到一个变量中,然后打印出cookie中的值,结果如下

Name = BAIDUID

Value = B07B663B645729F11F659C02AAE65B4C:FG=1

Name = BAIDUPSID

Value = B07B663B645729F11F659C02AAE65B4C

Name = H_PS_PSSID

Value = 12527_11076_1438_10633

Name = BDSVRTM

Value = 0

Name = BD_HOME

Value = 0

将 cookie 保存到文件

在上述方法中,我们将cookie保存到cookie变量中。如果我们想将 cookie 保存到文件中怎么办?这时候,我们将使用 FileCookieJar 对象,这里我们使用它的子类 MozillaCookieJar 来保存 cookie

mport cookielib

import urllib2

#设置保存cookie的文件,同级目录下的cookie.txt

filename = 'cookie.txt'

#声明一个MozillaCookieJar对象实例来保存cookie,之后写入文件

cookie = cookielib.MozillaCookieJar(filename)

#利用urllib2库的HTTPCookieProcessor对象来创建cookie处理器

handler = urllib2.HTTPCookieProcessor(cookie)

#通过handler来构建opener

opener = urllib2.build_opener(handler)

#创建一个请求,原理同urllib2的urlopen

response = opener.open("http://www.baidu.com";)

#保存cookie到文件

cookie.save(ignore_discard=True, ignore_expires=True)

正则表达式的正则表达式语法规则

java爬虫抓取网页数据(分布式网络新闻抓取系统的设计与实现(一)-上海怡健医学)

网站优化 • 优采云 发表了文章 • 0 个评论 • 59 次浏览 • 2022-04-01 14:26

1 项目介绍

本项目的主要内容是分布式网络新闻抓取系统的设计与实现。主要有以下几个部分要介绍:

(1)深入分析网络新闻爬虫特点,设计分布式网络新闻爬虫系统爬取策略、爬取领域、动态网络爬取方式、分布式结构、系统监控和数据存储六大关键功能。

(2)结合程序代码分解讲解分布式网络新闻爬虫系统的实现过程。包括爬虫编写、爬虫规避、动态网页数据爬取、分布式爬虫部署、系统监控,共六个内容,结合腾讯新闻数据的实际针对性抓取,通过测试来测试系统性能。

(3)规划设计了一个数据处理模块,包括数据清洗、代码转换、数据分类、对象添加等功能。

2. 分布式网络新闻抓取系统设计

2.1 整体系统架构设计

系统采用分布式主从结构,一台Master服务器和多台Slave服务器。Master 管理 Redis 数据库并分发下载任务。Slave 部署 Scrapy 抓取网页,解析提取项目数据。服务器的基本环境是Ubuntu操作系统,Master服务器安装Redis数据库服务器和Graphite,

Slave 安装 Scrapy 和 Redis 客户端。系统按功能可分为两大模块,一是数据采集模块,二是数据处理模块。数据抓取模块包括浏览器调用、网页下载、字段提取、爬虫规避、数据存储和系统监控六大功能;数据处理模块包括数据清洗、对象添加、编码转换和数据分类四个功能。

2.2 爬取策略设计

本项目的网络爬虫采用深度优先的爬取策略,根据设置下载网页数据。网页链接处理流程如下:

1.手动设置初始下载地址,一般是网站导航地址。

2.爬虫开始运行,从初始地址抓取第一个网页链接。

3、爬虫根据正则表达式识别新链接中的目录页地址和新闻内容页地址,将识别出的新地址加入待下载队列,等待被爬取,无法识别的网页地址为定义为无用的链接并丢弃。

4.爬虫依次取出要下载的网页链接,从待下载队列中提取数据。

5、下载队列为空,爬虫停止爬取。

新闻网站的导航页数是有限的,这个规则决定了新闻导航页的url在一定的人工参与下很容易获得,并作为爬虫系统的初始url。

2.3 爬取字段的设计

本项目的目的是捕捉网络新闻数据,因此内容必须能够客观、准确地反映网络新闻的特点。

以腾讯在线新闻数据的爬取为例,通过分析网页结构,确定了两步爬取步骤。第一步,抓取新闻内容页,获取新闻标题、新闻来源、新闻内容、发表时间、评论数、评论地址、相关搜索、用户仍喜欢的新闻、点赞数等9项内容;第二步,在获取评论地址后,抓取评论页面,获取评论者ID、评论者昵称、评论者性别、评论者所在地区、评论时间、评论内容、单条评论支持人数、回复数一条评论。

2.4 动态网页抓取方法设计

腾讯新闻网页使用Java生成动态网页内容。一些 JS 事件触发页面内容在打开时会发生变化,而一些网页在没有 JS 支持的情况下根本无法工作。普通爬虫根本无法从这些页面获取数据。解决Java动态网页爬取问题的方法有四种:

1、编写代码模拟相关的JS逻辑。

2. 调用带有界面的浏览器,类似于那些广泛用于测试的浏览器,例如 Selenium。

3、使用无界面浏览器,各种基于Webkit的,如Casperjs、Phantomjs等。

4.结合JS执行引擎,实现轻量级浏览器。

由于本项目是基于Python作为主要语言编写的,所以使用Selenium来处理JS

动态新闻页面。它的优点是简单和易于实施。使用Python代码模拟用户对浏览器的操作,首先将网页加载到浏览器中打开,然后从浏览器缓存中获取网页数据,传递给spider进行解析提取,最后将目标数据传递给项目频道。

2.5 爬虫分布式设计

使用Redis数据库实现分布式爬取。基本思路是Scrapy爬虫获取到的urls(request)

都放在一个 Redis Queue 中,所有爬虫也从指定的 Redis Queue 中获取请求(url)。

Scrapy-Redis 默认使用 Spider Priority Queue 来确定 url 的顺序,由 sorted set 决定

实现了非 FIFO 和 LIFO 方法。

Redis 存储了 Scrapy 项目的 request 和 stats 信息,根据这些信息可以掌握任务

情况和爬虫状态,在分配任务时很容易平衡系统负载,有助于克服爬虫的性能瓶颈。同时

利用 Redis 的高性能和易扩展性,可以轻松实现高效下载。当 Redis 存储或

当访问速度遇到问题时,可以通过增加 Redis 集群和爬虫集群的数量来提高。Scrapy-Redis

分布式解决方案解决了间歇性爬取和重复数据删除的问题。爬虫重启后会和Redis进行比较。

抓取队列中的url,已经抓取的url会被自动过滤掉。

2.6 基于Graphite系统的监控组件设计

使用Graphite监控系统运行状态,实现了一个分布式系统的statscollector,

系统的统计信息以图表的形式实时动态显示,即实时监控。Graphite监控的信息包括:系统下载信息、日志信息、文件数、调度信息、爬虫运行信息、爬虫异常信息、文件数、获取的项目数、最大请求深度、收到的响应数。

2.7 数据存储模块设计

Scrapy 支持 json、csv 和 xml 等文本格式的数据存储。用户可以在运行爬虫时设置,例如:scrapy crawlspider –o items.json –t json,或者在Scrapy项目文件的Item Pipeline中

在文件中定义。除此之外,Scrapy 还提供了多种数据库 API 来支持数据库存储。比如 MongoDB,

雷迪斯等人。数据存储分为两部分,一是网页链接的存储,二是项目数据的存储。网络链接存储

存储在Redis数据库中,用于实现分布式爬虫的下载管理;项目数据包括新闻数据和评论数据,以JSON格式保存为文本文件,方便处理。评论数据以评论url中收录的评论ID命名存储,这是一种将新闻数据与评论数据相关联的方式。

3 项目总结 查看全部

java爬虫抓取网页数据(分布式网络新闻抓取系统的设计与实现(一)-上海怡健医学)

1 项目介绍

本项目的主要内容是分布式网络新闻抓取系统的设计与实现。主要有以下几个部分要介绍:

(1)深入分析网络新闻爬虫特点,设计分布式网络新闻爬虫系统爬取策略、爬取领域、动态网络爬取方式、分布式结构、系统监控和数据存储六大关键功能。

(2)结合程序代码分解讲解分布式网络新闻爬虫系统的实现过程。包括爬虫编写、爬虫规避、动态网页数据爬取、分布式爬虫部署、系统监控,共六个内容,结合腾讯新闻数据的实际针对性抓取,通过测试来测试系统性能。

(3)规划设计了一个数据处理模块,包括数据清洗、代码转换、数据分类、对象添加等功能。

2. 分布式网络新闻抓取系统设计

2.1 整体系统架构设计

系统采用分布式主从结构,一台Master服务器和多台Slave服务器。Master 管理 Redis 数据库并分发下载任务。Slave 部署 Scrapy 抓取网页,解析提取项目数据。服务器的基本环境是Ubuntu操作系统,Master服务器安装Redis数据库服务器和Graphite,

Slave 安装 Scrapy 和 Redis 客户端。系统按功能可分为两大模块,一是数据采集模块,二是数据处理模块。数据抓取模块包括浏览器调用、网页下载、字段提取、爬虫规避、数据存储和系统监控六大功能;数据处理模块包括数据清洗、对象添加、编码转换和数据分类四个功能。

2.2 爬取策略设计

本项目的网络爬虫采用深度优先的爬取策略,根据设置下载网页数据。网页链接处理流程如下:

1.手动设置初始下载地址,一般是网站导航地址。

2.爬虫开始运行,从初始地址抓取第一个网页链接。

3、爬虫根据正则表达式识别新链接中的目录页地址和新闻内容页地址,将识别出的新地址加入待下载队列,等待被爬取,无法识别的网页地址为定义为无用的链接并丢弃。

4.爬虫依次取出要下载的网页链接,从待下载队列中提取数据。

5、下载队列为空,爬虫停止爬取。

新闻网站的导航页数是有限的,这个规则决定了新闻导航页的url在一定的人工参与下很容易获得,并作为爬虫系统的初始url。

2.3 爬取字段的设计

本项目的目的是捕捉网络新闻数据,因此内容必须能够客观、准确地反映网络新闻的特点。

以腾讯在线新闻数据的爬取为例,通过分析网页结构,确定了两步爬取步骤。第一步,抓取新闻内容页,获取新闻标题、新闻来源、新闻内容、发表时间、评论数、评论地址、相关搜索、用户仍喜欢的新闻、点赞数等9项内容;第二步,在获取评论地址后,抓取评论页面,获取评论者ID、评论者昵称、评论者性别、评论者所在地区、评论时间、评论内容、单条评论支持人数、回复数一条评论。

2.4 动态网页抓取方法设计

腾讯新闻网页使用Java生成动态网页内容。一些 JS 事件触发页面内容在打开时会发生变化,而一些网页在没有 JS 支持的情况下根本无法工作。普通爬虫根本无法从这些页面获取数据。解决Java动态网页爬取问题的方法有四种:

1、编写代码模拟相关的JS逻辑。

2. 调用带有界面的浏览器,类似于那些广泛用于测试的浏览器,例如 Selenium。

3、使用无界面浏览器,各种基于Webkit的,如Casperjs、Phantomjs等。

4.结合JS执行引擎,实现轻量级浏览器。

由于本项目是基于Python作为主要语言编写的,所以使用Selenium来处理JS

动态新闻页面。它的优点是简单和易于实施。使用Python代码模拟用户对浏览器的操作,首先将网页加载到浏览器中打开,然后从浏览器缓存中获取网页数据,传递给spider进行解析提取,最后将目标数据传递给项目频道。

2.5 爬虫分布式设计

使用Redis数据库实现分布式爬取。基本思路是Scrapy爬虫获取到的urls(request)

都放在一个 Redis Queue 中,所有爬虫也从指定的 Redis Queue 中获取请求(url)。

Scrapy-Redis 默认使用 Spider Priority Queue 来确定 url 的顺序,由 sorted set 决定

实现了非 FIFO 和 LIFO 方法。

Redis 存储了 Scrapy 项目的 request 和 stats 信息,根据这些信息可以掌握任务

情况和爬虫状态,在分配任务时很容易平衡系统负载,有助于克服爬虫的性能瓶颈。同时

利用 Redis 的高性能和易扩展性,可以轻松实现高效下载。当 Redis 存储或

当访问速度遇到问题时,可以通过增加 Redis 集群和爬虫集群的数量来提高。Scrapy-Redis

分布式解决方案解决了间歇性爬取和重复数据删除的问题。爬虫重启后会和Redis进行比较。

抓取队列中的url,已经抓取的url会被自动过滤掉。

2.6 基于Graphite系统的监控组件设计

使用Graphite监控系统运行状态,实现了一个分布式系统的statscollector,

系统的统计信息以图表的形式实时动态显示,即实时监控。Graphite监控的信息包括:系统下载信息、日志信息、文件数、调度信息、爬虫运行信息、爬虫异常信息、文件数、获取的项目数、最大请求深度、收到的响应数。

2.7 数据存储模块设计

Scrapy 支持 json、csv 和 xml 等文本格式的数据存储。用户可以在运行爬虫时设置,例如:scrapy crawlspider –o items.json –t json,或者在Scrapy项目文件的Item Pipeline中

在文件中定义。除此之外,Scrapy 还提供了多种数据库 API 来支持数据库存储。比如 MongoDB,

雷迪斯等人。数据存储分为两部分,一是网页链接的存储,二是项目数据的存储。网络链接存储

存储在Redis数据库中,用于实现分布式爬虫的下载管理;项目数据包括新闻数据和评论数据,以JSON格式保存为文本文件,方便处理。评论数据以评论url中收录的评论ID命名存储,这是一种将新闻数据与评论数据相关联的方式。

3 项目总结

java爬虫抓取网页数据(Python即时网络爬虫GitHub源7,文档修改历史(组图) )

网站优化 • 优采云 发表了文章 • 0 个评论 • 60 次浏览 • 2022-03-31 22:15

)

1 简介

本文介绍了如何使用 GooSeeker API 下载 Java 和 JavaScript 中的内容提取器。这是一个示例程序。什么是内容提取器?为什么要用这种方式?来自 Python Instant Web Crawler 开源项目:通过生成内容提取器来节省程序员的时间。详情请参阅“内容提取器的定义”。

2.用Java下载内容提取器

这是一系列示例程序之一。就目前编程语言的发展而言,Java并不适合提取网页内容。除了语言的不灵活和方便外,整个生态系统还不够活跃,可选类库增长缓慢。此外,要从 JavaScript 动态网页中提取内容,Java 也很不方便,需要 JavaScript 引擎。使用 JavaScript 下载内容提取器以直接跳到第 3 部分的内容。

执行

注解:

源代码如下:

public static void main(String[] args)

{

InputStream xslt = null;

try

{

String grabUrl = "http://m.58.com/cs/qiuzu/22613 ... 3B%3B // 抓取网址

String resultPath = "F:/temp/xslt/result.xml"; // 抓取结果文件的存放路径

// 通过GooSeeker API接口获得xslt

xslt = getGsExtractor();

// 抓取网页内容转换结果文件

convertXml(grabUrl, xslt, resultPath);

} catch (Exception e)

{

e.printStackTrace();

} finally

{

try

{

if (xslt != null)

xslt.close();

} catch (IOException e)

{

e.printStackTrace();

}

}

}

/**

* @description dom转换

*/

public static void convertXml(String grabUrl, InputStream xslt, String resultPath) throws Exception

{

// 这里的doc对象指的是jsoup里的Document对象

org.jsoup.nodes.Document doc = Jsoup.parse(new URL(grabUrl).openStream(), "UTF-8", grabUrl);

W3CDom w3cDom = new W3CDom();

// 这里的w3cDoc对象指的是w3c里的Document对象

org.w3c.dom.Document w3cDoc = w3cDom.fromJsoup(doc);

Source srcSource = new DOMSource(w3cDoc);

TransformerFactory tFactory = TransformerFactory.newInstance();

Transformer transformer = tFactory.newTransformer(new StreamSource(xslt));

transformer.transform(srcSource, new StreamResult(new FileOutputStream(resultPath)));

}

/**

* @description 获取API返回结果

*/

public static InputStream getGsExtractor()

{

// api接口

String apiUrl = "http://www.gooseeker.com/api/getextractor";

// 请求参数

Map params = new HashMap();

params.put("key", "xxx"); // Gooseeker会员中心申请的API KEY

params.put("theme", "xxx"); // 提取器名,就是用MS谋数台定义的规则名

params.put("middle", "xxx"); // 规则编号,如果相同规则名下定义了多个规则,需填写

params.put("bname", "xxx"); // 整理箱名,如果规则含有多个整理箱,需填写

String httpArg = urlparam(params);

apiUrl = apiUrl + "?" + httpArg;

InputStream is = null;

try

{

URL url = new URL(apiUrl);

HttpURLConnection urlCon = (HttpURLConnection) url.openConnection();

urlCon.setRequestMethod("GET");

is = urlCon.getInputStream();

} catch (ProtocolException e)

{

e.printStackTrace();

} catch (IOException e)

{

e.printStackTrace();

}

return is;

}

/**

* @description 请求参数

*/

public static String urlparam(Map data)

{

StringBuilder sb = new StringBuilder();

for (Map.Entry entry : data.entrySet())

{

try

{

sb.append(entry.getKey()).append("=").append(URLEncoder.encode(entry.getValue() + "", "UTF-8")).append("&");

} catch (UnsupportedEncodingException e)

{

e.printStackTrace();

}

}

return sb.toString();

}

返回结果如下:

3. 使用 JavaScript 下载内容提取器

请注意,如果本示例中的 JavaScript 代码运行在网页上,由于跨域问题,无法抓取非本地网页的内容。因此,需要在特权JavaScript引擎上运行,例如浏览器扩展、自研浏览器、自身程序中的JavaScript引擎等。

为了实验的方便,这个例子还在网页上运行。为了绕过跨域问题,保存并修改目标网页,并在其中插入JavaScript。这么多手动操作只是为了实验,正式使用时还需要考虑其他手段。

执行

注解:

这是源代码:

返回结果截图如下

4、展望

您还可以使用 Python 来获取指定网页的内容。我觉得Python的语法更简洁。以后我会添加 Python 语言的例子。有兴趣的朋友可以加入研究。

五、相关文件

Python Instant Web Crawler:API 说明

6.Jisouke GooSeeker开源代码下载源

GooSeeker 开源 Python 网络爬虫 GitHub 源码

7.文档修改历史

2016-06-20: V1.0

如有疑问,您可以或

查看全部

java爬虫抓取网页数据(Python即时网络爬虫GitHub源7,文档修改历史(组图)

)

1 简介

本文介绍了如何使用 GooSeeker API 下载 Java 和 JavaScript 中的内容提取器。这是一个示例程序。什么是内容提取器?为什么要用这种方式?来自 Python Instant Web Crawler 开源项目:通过生成内容提取器来节省程序员的时间。详情请参阅“内容提取器的定义”。

2.用Java下载内容提取器

这是一系列示例程序之一。就目前编程语言的发展而言,Java并不适合提取网页内容。除了语言的不灵活和方便外,整个生态系统还不够活跃,可选类库增长缓慢。此外,要从 JavaScript 动态网页中提取内容,Java 也很不方便,需要 JavaScript 引擎。使用 JavaScript 下载内容提取器以直接跳到第 3 部分的内容。

执行

注解:

源代码如下:

public static void main(String[] args)

{

InputStream xslt = null;

try

{

String grabUrl = "http://m.58.com/cs/qiuzu/22613 ... 3B%3B // 抓取网址

String resultPath = "F:/temp/xslt/result.xml"; // 抓取结果文件的存放路径

// 通过GooSeeker API接口获得xslt

xslt = getGsExtractor();

// 抓取网页内容转换结果文件

convertXml(grabUrl, xslt, resultPath);

} catch (Exception e)

{

e.printStackTrace();

} finally

{

try

{

if (xslt != null)

xslt.close();

} catch (IOException e)

{

e.printStackTrace();

}

}

}

/**

* @description dom转换

*/

public static void convertXml(String grabUrl, InputStream xslt, String resultPath) throws Exception

{

// 这里的doc对象指的是jsoup里的Document对象

org.jsoup.nodes.Document doc = Jsoup.parse(new URL(grabUrl).openStream(), "UTF-8", grabUrl);

W3CDom w3cDom = new W3CDom();

// 这里的w3cDoc对象指的是w3c里的Document对象

org.w3c.dom.Document w3cDoc = w3cDom.fromJsoup(doc);

Source srcSource = new DOMSource(w3cDoc);

TransformerFactory tFactory = TransformerFactory.newInstance();

Transformer transformer = tFactory.newTransformer(new StreamSource(xslt));

transformer.transform(srcSource, new StreamResult(new FileOutputStream(resultPath)));

}

/**

* @description 获取API返回结果

*/

public static InputStream getGsExtractor()

{

// api接口

String apiUrl = "http://www.gooseeker.com/api/getextractor";

// 请求参数

Map params = new HashMap();

params.put("key", "xxx"); // Gooseeker会员中心申请的API KEY

params.put("theme", "xxx"); // 提取器名,就是用MS谋数台定义的规则名

params.put("middle", "xxx"); // 规则编号,如果相同规则名下定义了多个规则,需填写

params.put("bname", "xxx"); // 整理箱名,如果规则含有多个整理箱,需填写

String httpArg = urlparam(params);

apiUrl = apiUrl + "?" + httpArg;

InputStream is = null;

try

{

URL url = new URL(apiUrl);

HttpURLConnection urlCon = (HttpURLConnection) url.openConnection();

urlCon.setRequestMethod("GET");

is = urlCon.getInputStream();

} catch (ProtocolException e)

{

e.printStackTrace();

} catch (IOException e)

{

e.printStackTrace();

}

return is;

}

/**

* @description 请求参数

*/

public static String urlparam(Map data)

{

StringBuilder sb = new StringBuilder();