java抓取网页内容

如何使用PYTHON抓取新闻文章

网站优化 • 优采云 发表了文章 • 0 个评论 • 73 次浏览 • 2022-05-09 21:15

r

在本文中,我们将讨论如何使用Python抓取新闻报道。这可以使用方便的报纸包装来完成。

Pythonnewspaper包简介

可以使用pip安装newspaper包:

pip install newspaper

安装完成后,即可开始。newspaper可以通过从给定的URL上抓取一篇文章,或者通过找到网页上其他新闻的链接来工作。让我们从处理一篇文章开始。首先,我们需要导入Article类。接下来,我们使用此类将内容从URL下载到我们的新闻文章。然后,我们使用parse方法解析HTML。最后,我们可以使用.text打印文章的文本。

爬一篇文章

from newspaper import Article url = "https://www.bloomberg.com/news ... ot%3B # download and parse articlearticle = Article(url)article.download()article.parse() # print article textprint(article.text)

还可以获取有关文章的其他信息,例如指向帖子中嵌入的图像或视频的链接。

# get list of image linksarticle.images # get list of videos - empty in this casearticle.movies

下载网页上链接的所有文章

现在,让我们看看如何将所有新闻文章链接到网页上。我们将使用如下的news.build方法来实现。然后,我们可以使用article_urls方法提取文章URL。

import newspaper site = newspaper.build("https://news.ycombinator.com/") # get list of article URLssite.article_urls()

使用上面的对象,我们还可以获得每个文章的内容。这里,所有article对象都存储在list.site.articles中。例如,让我们获取第一篇文章的内容。

site_article = site.articles[0] site_article.download()site_article.parse() print(site_article.text)

现在,让我们修改代码以获得前十名文章:

top_articles = []for index in range(10): article = site.articles[index] article.download() article.parse() top_articles.append(article)

警告!

使用时,一个重要的说明newspaper的是,如果你运行newspaper.build用相同的URL多次,

包将缓存,然后删除已经刮了文章。例如,在下面的代码中,我们连续两次运行Newspaper.build并获得不同的结果。第二次运行它时,代码仅返回新添加的链接。

site = newspaper.build("https://news.ycombinator.com/") print(len(site.articles)) site = newspaper.build("https://news.ycombinator.com/") print(len(site.articles))<br />

可以通过在函数调用中添加一个额外的参数来进行调整,如下所示:

如何获得文章摘要

该newspaper包也支持一些NLP功能。您可以通过调用nlp方法进行检查。

article = top_articles[3] article.nlp()

现在,让我们使用summary方法。这将尝试返回文章摘要。

article.summary()

您还可以从文章中获取关键字列表。

article.keywords

如何获得最热门的Google关键字

报纸还有其他一些很酷的功能。例如,我们可以使用hot方法轻松使用它在Google上吸引最热门的搜索。

newspaper.hot()

该软件包还可以返回受欢迎的URL列表,如下所示。

newspaper.popular_urls() 查看全部

如何使用PYTHON抓取新闻文章

r

在本文中,我们将讨论如何使用Python抓取新闻报道。这可以使用方便的报纸包装来完成。

Pythonnewspaper包简介

可以使用pip安装newspaper包:

pip install newspaper

安装完成后,即可开始。newspaper可以通过从给定的URL上抓取一篇文章,或者通过找到网页上其他新闻的链接来工作。让我们从处理一篇文章开始。首先,我们需要导入Article类。接下来,我们使用此类将内容从URL下载到我们的新闻文章。然后,我们使用parse方法解析HTML。最后,我们可以使用.text打印文章的文本。

爬一篇文章

from newspaper import Article url = "https://www.bloomberg.com/news ... ot%3B # download and parse articlearticle = Article(url)article.download()article.parse() # print article textprint(article.text)

还可以获取有关文章的其他信息,例如指向帖子中嵌入的图像或视频的链接。

# get list of image linksarticle.images # get list of videos - empty in this casearticle.movies

下载网页上链接的所有文章

现在,让我们看看如何将所有新闻文章链接到网页上。我们将使用如下的news.build方法来实现。然后,我们可以使用article_urls方法提取文章URL。

import newspaper site = newspaper.build("https://news.ycombinator.com/";) # get list of article URLssite.article_urls()

使用上面的对象,我们还可以获得每个文章的内容。这里,所有article对象都存储在list.site.articles中。例如,让我们获取第一篇文章的内容。

site_article = site.articles[0] site_article.download()site_article.parse() print(site_article.text)

现在,让我们修改代码以获得前十名文章:

top_articles = []for index in range(10): article = site.articles[index] article.download() article.parse() top_articles.append(article)

警告!

使用时,一个重要的说明newspaper的是,如果你运行newspaper.build用相同的URL多次,

包将缓存,然后删除已经刮了文章。例如,在下面的代码中,我们连续两次运行Newspaper.build并获得不同的结果。第二次运行它时,代码仅返回新添加的链接。

site = newspaper.build("https://news.ycombinator.com/";) print(len(site.articles)) site = newspaper.build("https://news.ycombinator.com/";) print(len(site.articles))<br />

可以通过在函数调用中添加一个额外的参数来进行调整,如下所示:

如何获得文章摘要

该newspaper包也支持一些NLP功能。您可以通过调用nlp方法进行检查。

article = top_articles[3] article.nlp()

现在,让我们使用summary方法。这将尝试返回文章摘要。

article.summary()

您还可以从文章中获取关键字列表。

article.keywords

如何获得最热门的Google关键字

报纸还有其他一些很酷的功能。例如,我们可以使用hot方法轻松使用它在Google上吸引最热门的搜索。

newspaper.hot()

该软件包还可以返回受欢迎的URL列表,如下所示。

newspaper.popular_urls()

网站页面不收录的常见原因

网站优化 • 优采云 发表了文章 • 0 个评论 • 70 次浏览 • 2022-05-05 09:31

1、网页使用框架:框架内的内容通常不在搜索引擎抓取的范围之内。

2、图片太多,文本太少。

3、提交页面转向另一网站:搜索引擎可能完全跳过这个页面。

4、提交太过频繁:一个月内提交2次以上,很多搜索引擎就受不了,认为你在提交垃圾。

5、网站关键词密度太大:不幸的是搜索引擎并没解释多高的密度是极限,一般认为100个字的描述中含有3-4个关键词为最佳。

6、文本颜色跟背景色彩一样:搜索引擎认为你在堆砌关键词欺骗它。

7、动态网页:网站的内容管理系统方便了网页更新,却给大部分搜索引擎带来麻烦,很多搜索引擎不收取动态页面,或只收取第一层页面,不会向下深入收取。这时要考虑使用WEB服务器的重写(rewrite)技术,把动态页面的url映射成和静态页面url相似的格式,搜索引擎误以为是静态页面,就会收取了。

8、网站转移服务器:搜索引擎通常只认IP地址,转换主机或域名时,IP/DNS地址发生改变,这时你要重新提交网站。

9、免费的网站空间:有的搜索引擎拒绝索引来自免费空间的网站,抱怨很多垃圾,质量差。

10、搜索引擎抓取时网站不在线:如果主机不稳定,就有可能出现这种情况。更糟糕的是,即使网站已经收录,重新抓取时发现不在线,还会将网站整个删除。

11、错误地阻挡了robots索引网站:有两种方法可能阻挡robots:主机服务器的根目录下有简单文本文件;网页中含某种META标签。

12、大量运用Flash、DHTML、cookies、JavaScript、Java制作或密码进入的网页,搜索引擎很难从这种页面中提取内容。

13、搜索引擎不能解析你的DNS:新域名注册后需要1-2天的时间才能生效,因此不要一注册了域名马上提交网站。

14、网站的链接广泛度太低:链接广泛度太低,搜索引擎难以找到你,这时要考虑把网站登录到知名分类目录,或多做几个友情链接。

15、服务器速度太慢:网络带宽小,网页下载速度太慢,或者网页太复杂,都可能导致搜索引擎还没搜到文本内容就暂停。

16、关键字问题:如果正文没有出现你的META标签中提到的关键字,搜索引擎可能以为是垃圾关键字。 查看全部

网站页面不收录的常见原因

1、网页使用框架:框架内的内容通常不在搜索引擎抓取的范围之内。

2、图片太多,文本太少。

3、提交页面转向另一网站:搜索引擎可能完全跳过这个页面。

4、提交太过频繁:一个月内提交2次以上,很多搜索引擎就受不了,认为你在提交垃圾。

5、网站关键词密度太大:不幸的是搜索引擎并没解释多高的密度是极限,一般认为100个字的描述中含有3-4个关键词为最佳。

6、文本颜色跟背景色彩一样:搜索引擎认为你在堆砌关键词欺骗它。

7、动态网页:网站的内容管理系统方便了网页更新,却给大部分搜索引擎带来麻烦,很多搜索引擎不收取动态页面,或只收取第一层页面,不会向下深入收取。这时要考虑使用WEB服务器的重写(rewrite)技术,把动态页面的url映射成和静态页面url相似的格式,搜索引擎误以为是静态页面,就会收取了。

8、网站转移服务器:搜索引擎通常只认IP地址,转换主机或域名时,IP/DNS地址发生改变,这时你要重新提交网站。

9、免费的网站空间:有的搜索引擎拒绝索引来自免费空间的网站,抱怨很多垃圾,质量差。

10、搜索引擎抓取时网站不在线:如果主机不稳定,就有可能出现这种情况。更糟糕的是,即使网站已经收录,重新抓取时发现不在线,还会将网站整个删除。

11、错误地阻挡了robots索引网站:有两种方法可能阻挡robots:主机服务器的根目录下有简单文本文件;网页中含某种META标签。

12、大量运用Flash、DHTML、cookies、JavaScript、Java制作或密码进入的网页,搜索引擎很难从这种页面中提取内容。

13、搜索引擎不能解析你的DNS:新域名注册后需要1-2天的时间才能生效,因此不要一注册了域名马上提交网站。

14、网站的链接广泛度太低:链接广泛度太低,搜索引擎难以找到你,这时要考虑把网站登录到知名分类目录,或多做几个友情链接。

15、服务器速度太慢:网络带宽小,网页下载速度太慢,或者网页太复杂,都可能导致搜索引擎还没搜到文本内容就暂停。

16、关键字问题:如果正文没有出现你的META标签中提到的关键字,搜索引擎可能以为是垃圾关键字。

java抓取网页内容(如何通过java抓取网页内容,提取关键信息java基于/jsp框架进行网页分析)

网站优化 • 优采云 发表了文章 • 0 个评论 • 74 次浏览 • 2022-04-18 02:02

java抓取网页内容,提取关键信息java基于java/jsp框架进行网页抓取分析,熟悉java有助于你更好的理解java爬虫不同于别的编程语言中,要掌握java的多线程编程等,下面我们就要讲述一下如何通过java熟练掌握java爬虫技术。本次使用androidstudio来开发手机上的java爬虫软件.首先要安装java,如果你不想安装也没有关系,后面的使用将会用到。

安装好java后,我们可以测试java是否正常运行,打开手机的控制台(如下图),有没有在控制台上看到黄色字体(javasystemoperation)。如果没有的话,那么你在安装的时候就选错了,选择lib,因为java的版本不一样。如果javasystemoperation出现了,那么恭喜你,java有问题。

当然,java有问题在我们写代码上还有一些方法,会帮助我们减少出现问题的几率。看来刚刚安装java还是没有关系的,接下来就可以进行下一步了。有人问我如何写代码才可以运行,这个可以写成python的循环模式,大概代码如下:简单描述packagecn.guanwenshan.cat;importcn.guanwenshan.python.get;importcn.guanwenshan.python.pipe;importcn.guanwenshan.python.print;importcn.guanwenshan.python.socket;importcn.guanwenshan.python.get.windows.getmodulename;importcn.guanwenshan.python.get.windows.create.createdirectory;importcn.guanwenshan.python.get.windows.create.dbgetall;importcn.guanwenshan.python.get.windows.create.dbgetall;importcn.guanwenshan.python.get.windows.create.dbgetall;publicclassjavawebrequest{publicstaticfinallongsystem_const_aload_to_read_fd=5;publicstaticfinalintdirectory_max_size=32940491400;publicstaticfinalintwindows_administrator_sc_windows_fuzz=1l;publicstaticfinalintwindows_administrator_sc_windows_fuzz=1l;publicstaticfinalbooleanuse_random(){returnfalse;}publicstaticfinalbooleanuse_cracked(){returnfalse;}publicstaticvoidmain(string[]args){try{javawebrequesttr=newjavawebrequest("lw=/index.asp");catrh=newcat(tr);windowsclientctx=newwindowsclient(tr);socketsocket=newsocket。 查看全部

java抓取网页内容(如何通过java抓取网页内容,提取关键信息java基于/jsp框架进行网页分析)

java抓取网页内容,提取关键信息java基于java/jsp框架进行网页抓取分析,熟悉java有助于你更好的理解java爬虫不同于别的编程语言中,要掌握java的多线程编程等,下面我们就要讲述一下如何通过java熟练掌握java爬虫技术。本次使用androidstudio来开发手机上的java爬虫软件.首先要安装java,如果你不想安装也没有关系,后面的使用将会用到。

安装好java后,我们可以测试java是否正常运行,打开手机的控制台(如下图),有没有在控制台上看到黄色字体(javasystemoperation)。如果没有的话,那么你在安装的时候就选错了,选择lib,因为java的版本不一样。如果javasystemoperation出现了,那么恭喜你,java有问题。

当然,java有问题在我们写代码上还有一些方法,会帮助我们减少出现问题的几率。看来刚刚安装java还是没有关系的,接下来就可以进行下一步了。有人问我如何写代码才可以运行,这个可以写成python的循环模式,大概代码如下:简单描述packagecn.guanwenshan.cat;importcn.guanwenshan.python.get;importcn.guanwenshan.python.pipe;importcn.guanwenshan.python.print;importcn.guanwenshan.python.socket;importcn.guanwenshan.python.get.windows.getmodulename;importcn.guanwenshan.python.get.windows.create.createdirectory;importcn.guanwenshan.python.get.windows.create.dbgetall;importcn.guanwenshan.python.get.windows.create.dbgetall;importcn.guanwenshan.python.get.windows.create.dbgetall;publicclassjavawebrequest{publicstaticfinallongsystem_const_aload_to_read_fd=5;publicstaticfinalintdirectory_max_size=32940491400;publicstaticfinalintwindows_administrator_sc_windows_fuzz=1l;publicstaticfinalintwindows_administrator_sc_windows_fuzz=1l;publicstaticfinalbooleanuse_random(){returnfalse;}publicstaticfinalbooleanuse_cracked(){returnfalse;}publicstaticvoidmain(string[]args){try{javawebrequesttr=newjavawebrequest("lw=/index.asp");catrh=newcat(tr);windowsclientctx=newwindowsclient(tr);socketsocket=newsocket。

java抓取网页内容(301redirect:301代表永久性转移(PermanentlyMoved) )

网站优化 • 优采云 发表了文章 • 0 个评论 • 94 次浏览 • 2022-04-16 10:38

)

一直对http状态码301和302有一个模糊的认识,在遇到实际问题,看了各种资料后,有了一定的了解。记录在这里,希望能有新的认识。我们都分享。

官方更简洁的描述:

301 重定向:301 代表永久移动

302重定向:302代表Temporarily Moved

ps:这里我还记得两个比较相似的英文单词(permanently,temporary),嘻哈!

详细来说,301和302状态码都表示重定向,意思是浏览器在获取到服务器返回的状态码后会自动跳转到新的URL地址,可以从响应的Location头中获取。(用户看到的效果是他输入的地址A瞬间变成了另一个地址B)——这就是他们的共同点。他们的区别是。301表示旧地址A的资源已被永久移除(资源不可访问),搜索引擎在爬取新内容的同时也将旧URL与重定向的URL交换;302表示A的旧地址资源还在(仍然可以访问),这个重定向只是从旧地址A临时跳转到地址B,

这里开启傻瓜自问自答模式(你可能会想到的问题):

1、什么是重定向?

即地址A跳转到地址B。百度百科的解释:重定向就是通过各种方法将各种网络请求重定向到其他位置(比如网页重定向,域名重定向,路由变化也是路径的一部分)数据包。重定向)。

2、但是为什么要重定向呢?什么时候需要重定向?

想跳就跳,跳得漂亮。或者从维基百科学习:

1)网站调整(如改变网页目录结构);

2)网页已移至新地址;

3)网页的扩展名发生了变化(例如应用程序需要将.php改为.Html或.shtml)。

在这种情况下,如果不进行重定向,用户采集夹或搜索引擎数据库中的旧地址只能让访问客户得到404页面错误信息,访问流量将白白流失;网站,还需要重定向访问这些域名的用户自动跳转到主站点等。

3、那么,你什么时候进行 301 或 302 跳转?

当一个网站或网页在24-48小时内临时移动到新位置时,需要进行302跳转。比如我有房子,但最近去亲戚家住。,我两天后回来。使用301跳转的场景是之前的网站由于某种原因需要去掉,然后需要在新的地址访问,是永久的。例如,您的房子实际上是出租的。现在当租约到期时,你在另一个地方找到了房子,而你之前租的房子已经不在了。

为了清楚和明确:

使用 301 跳转的场景:

1)域名到期不想续费(或者找一个更适合网站的域名),想换个域名。

2)搜索引擎搜索结果中出现不带www的域名,带www的域名却不带收录。这时候可以通过301重定向告诉搜索引擎我们的目标域名在哪里。一。

3)换空间时,空间服务器不稳定。

使用 302 跳转的场景:

——尽量使用301跳跃!

4、为什么要尝试使用301跳转?- URL劫持!

这里摘自百度百科的解释:

在做从 URL A 到 URL B 的 302 重定向时,主机服务器的隐含含义是 URL A 可能随时改变主意,重新显示自己的内容或重定向到其他地方。大多数情况下,当接收到302重定向时,大部分搜索引擎只需要爬取目标URL,即URL B。如果搜索引擎在遇到302重定向时100%爬取目标URL B,则不需要担心 URL 劫持。问题是有时搜索引擎,尤其是谷歌,并不总是抓取目标 URL。比如有时候A URL很短,但是却做了302重定向到B URL,而B URL是一个长的乱七八糟的URL URL,甚至可能收录一些参数如问号。自然,A URL 更人性化,而 B URL 丑陋且不人性化。Google 很有可能此时仍会显示 URL A。由于搜索引擎排名算法只是一个程序而不是人,因此在遇到302重定向时,它无法像人一样准确地确定哪个URL更合适,从而导致URL劫持的可能性。也就是不法之徒对自己的网址A做了302重定向到你的网址B,不知为何,谷歌搜索结果还是显示了网址A,但是使用的页面内容却是你的网址B上的内容,这这种情况称为 URL 劫持。你辛辛苦苦写出来的内容,刚刚被别人盗用了。由 302 重定向引起的 URL 劫持已经存在了一段时间。但到目前为止,似乎没有更好的解决方案。在正在进行的 Google Big Daddy 数据中心转换中,302重定向问题也是要解决的目标之一。从部分搜索结果来看,URL劫持现象有所改善,但并未彻底解决。

我的理解是,当我从网站A(网站比较差)到网站B(搜索排名很高)进行302跳转时,有时搜索引擎会使用网站B 的内容,但是 收录 的地址是 网站A,所以 网站B 在不知不觉中为 网站A 做出贡献,网站A的排名更高。

301重定向对于搜索引擎来说是一个比较良性的重定向系统,也是搜索引擎可以遇到的重定向系统。它告诉搜索引擎该地址已被弃用,并且将始终转向一个新地址,该地址可以转移新域名的权重。而302重定向很容易被搜索引擎误认为使用多个域名指向同一个网站,那么你的网站就会以“使用重复内容干扰谷歌搜索结果”为由被屏蔽网站排名”。

自问自答模式告一段落。这里分享一下我在NodeJs中跳跃的场景:

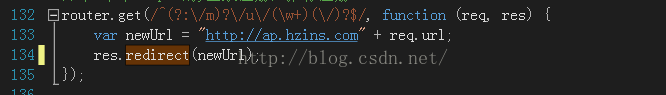

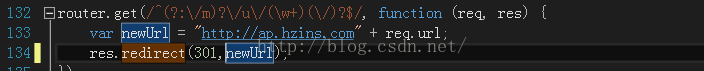

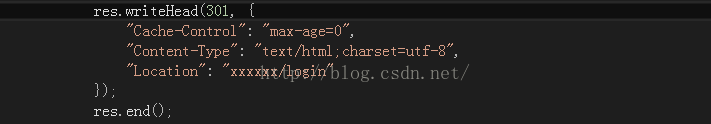

我们之前做过一个重构项目。由于各种原因,我们的网站的登录和注册部分需要分离成另一个网站,域名和之前的不一样,所以需要保证旧地址可以也可以重定向到地址,我们在旧系统的节点层做了一个重定向,代码类似这样:

这里没有设置状态码。发现默认是302跳转,然后我们设置301状态码,像这样:

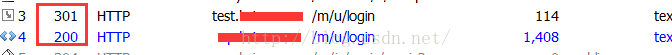

用fiddle抓包(上面的302调整我就不拍了),看看效果:

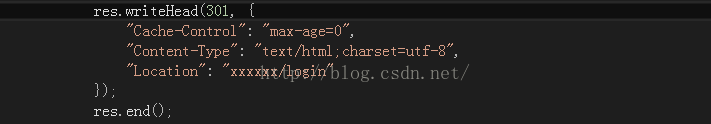

上面是使用Express,使用nodejs原生代码来实现这样的东西:

查看全部

java抓取网页内容(301redirect:301代表永久性转移(PermanentlyMoved)

)

一直对http状态码301和302有一个模糊的认识,在遇到实际问题,看了各种资料后,有了一定的了解。记录在这里,希望能有新的认识。我们都分享。

官方更简洁的描述:

301 重定向:301 代表永久移动

302重定向:302代表Temporarily Moved

ps:这里我还记得两个比较相似的英文单词(permanently,temporary),嘻哈!

详细来说,301和302状态码都表示重定向,意思是浏览器在获取到服务器返回的状态码后会自动跳转到新的URL地址,可以从响应的Location头中获取。(用户看到的效果是他输入的地址A瞬间变成了另一个地址B)——这就是他们的共同点。他们的区别是。301表示旧地址A的资源已被永久移除(资源不可访问),搜索引擎在爬取新内容的同时也将旧URL与重定向的URL交换;302表示A的旧地址资源还在(仍然可以访问),这个重定向只是从旧地址A临时跳转到地址B,

这里开启傻瓜自问自答模式(你可能会想到的问题):

1、什么是重定向?

即地址A跳转到地址B。百度百科的解释:重定向就是通过各种方法将各种网络请求重定向到其他位置(比如网页重定向,域名重定向,路由变化也是路径的一部分)数据包。重定向)。

2、但是为什么要重定向呢?什么时候需要重定向?

想跳就跳,跳得漂亮。或者从维基百科学习:

1)网站调整(如改变网页目录结构);

2)网页已移至新地址;

3)网页的扩展名发生了变化(例如应用程序需要将.php改为.Html或.shtml)。

在这种情况下,如果不进行重定向,用户采集夹或搜索引擎数据库中的旧地址只能让访问客户得到404页面错误信息,访问流量将白白流失;网站,还需要重定向访问这些域名的用户自动跳转到主站点等。

3、那么,你什么时候进行 301 或 302 跳转?

当一个网站或网页在24-48小时内临时移动到新位置时,需要进行302跳转。比如我有房子,但最近去亲戚家住。,我两天后回来。使用301跳转的场景是之前的网站由于某种原因需要去掉,然后需要在新的地址访问,是永久的。例如,您的房子实际上是出租的。现在当租约到期时,你在另一个地方找到了房子,而你之前租的房子已经不在了。

为了清楚和明确:

使用 301 跳转的场景:

1)域名到期不想续费(或者找一个更适合网站的域名),想换个域名。

2)搜索引擎搜索结果中出现不带www的域名,带www的域名却不带收录。这时候可以通过301重定向告诉搜索引擎我们的目标域名在哪里。一。

3)换空间时,空间服务器不稳定。

使用 302 跳转的场景:

——尽量使用301跳跃!

4、为什么要尝试使用301跳转?- URL劫持!

这里摘自百度百科的解释:

在做从 URL A 到 URL B 的 302 重定向时,主机服务器的隐含含义是 URL A 可能随时改变主意,重新显示自己的内容或重定向到其他地方。大多数情况下,当接收到302重定向时,大部分搜索引擎只需要爬取目标URL,即URL B。如果搜索引擎在遇到302重定向时100%爬取目标URL B,则不需要担心 URL 劫持。问题是有时搜索引擎,尤其是谷歌,并不总是抓取目标 URL。比如有时候A URL很短,但是却做了302重定向到B URL,而B URL是一个长的乱七八糟的URL URL,甚至可能收录一些参数如问号。自然,A URL 更人性化,而 B URL 丑陋且不人性化。Google 很有可能此时仍会显示 URL A。由于搜索引擎排名算法只是一个程序而不是人,因此在遇到302重定向时,它无法像人一样准确地确定哪个URL更合适,从而导致URL劫持的可能性。也就是不法之徒对自己的网址A做了302重定向到你的网址B,不知为何,谷歌搜索结果还是显示了网址A,但是使用的页面内容却是你的网址B上的内容,这这种情况称为 URL 劫持。你辛辛苦苦写出来的内容,刚刚被别人盗用了。由 302 重定向引起的 URL 劫持已经存在了一段时间。但到目前为止,似乎没有更好的解决方案。在正在进行的 Google Big Daddy 数据中心转换中,302重定向问题也是要解决的目标之一。从部分搜索结果来看,URL劫持现象有所改善,但并未彻底解决。

我的理解是,当我从网站A(网站比较差)到网站B(搜索排名很高)进行302跳转时,有时搜索引擎会使用网站B 的内容,但是 收录 的地址是 网站A,所以 网站B 在不知不觉中为 网站A 做出贡献,网站A的排名更高。

301重定向对于搜索引擎来说是一个比较良性的重定向系统,也是搜索引擎可以遇到的重定向系统。它告诉搜索引擎该地址已被弃用,并且将始终转向一个新地址,该地址可以转移新域名的权重。而302重定向很容易被搜索引擎误认为使用多个域名指向同一个网站,那么你的网站就会以“使用重复内容干扰谷歌搜索结果”为由被屏蔽网站排名”。

自问自答模式告一段落。这里分享一下我在NodeJs中跳跃的场景:

我们之前做过一个重构项目。由于各种原因,我们的网站的登录和注册部分需要分离成另一个网站,域名和之前的不一样,所以需要保证旧地址可以也可以重定向到地址,我们在旧系统的节点层做了一个重定向,代码类似这样:

这里没有设置状态码。发现默认是302跳转,然后我们设置301状态码,像这样:

用fiddle抓包(上面的302调整我就不拍了),看看效果:

上面是使用Express,使用nodejs原生代码来实现这样的东西:

java抓取网页内容(java抓取网页内容的主要有三个步骤:抓取逻辑)

网站优化 • 优采云 发表了文章 • 0 个评论 • 79 次浏览 • 2022-04-15 13:04

java抓取网页内容,主要有三个步骤:数据预处理、数据提取、数据分析。

1、文字处理,处理网页上的文字。

2、单行、多行文本提取,转换成数字型文本。

3、扫描函数,即将网页上的条件格式数据扫描成一个一个的规则元素,方便抓取。

数据提取部分:

1、通过java的connection提供的方法(接收键值对),将提取到的值传递给数据库,利用查询语句查询数据库中的值。

2、利用servlet的connectionservice封装接收到的值,并完成servlet的上下文切换。

3、提取需要的数据。

4、用objectresolver,遍历数据库,返回需要提取的值。

5、存储、读取字符串。

6、查询相应的值,得到需要的值。

数据分析部分:

1、继续以上步骤,得到所需要的数据。

2、分析获取到的数据,并提取相应的值。

3、用openresolver读取所需要的值,得到传递给httpclient的参数列表,传递给httpclient,发送给servlet,并传递给service对象、webservice对象。

4、service对象继续代表connectionservice,开始读取并发送相应的参数。

对于分析网页数据来说,也就是对于lz这种做业务的程序员来说,是不分前后端的,api接口模拟登录按钮等数据,接入jq,mybatis,hibernate等提供的api参数和数据,一切都处理完成即可,这种模式适合restful架构下的,jsonjsonp发包给浏览器,页面逻辑处理完成直接返回response就行了,提供restfulapi即可。

而对于抓取来说,前端处理和后端处理都需要,抓取的抓取逻辑是关键,像前端网页是根据userid登录,用户id类型等等因素抓取,后端就是抓取与用户id绑定过的信息、包括在页面中的回调函数等等,抓取之后可以拿到api返回的response(通过验证)也可以转存到数据库中,当然可以顺便做些数据库查询等操作,还可以结合第三方springcloud平台,连接服务发现注册,因为现在看来不少业务都是用springboot+mybatis/springcloud作为业务基础架构,restful协议也随之统一。

了解到以上还不过瘾,还可以了解下,aiohttp,简单易用,有丰富的示例,代码量少,作为后端来说也很方便,在代码量上也很可观,重点是作为后端抓取来说轻便,代码不会过于冗余,轻量级的代码体积不会过大,工作负担也小。以上只是代表个人对抓取的理解,具体还得抓包、分析等实战来学习,才能真正理解抓取。 查看全部

java抓取网页内容(java抓取网页内容的主要有三个步骤:抓取逻辑)

java抓取网页内容,主要有三个步骤:数据预处理、数据提取、数据分析。

1、文字处理,处理网页上的文字。

2、单行、多行文本提取,转换成数字型文本。

3、扫描函数,即将网页上的条件格式数据扫描成一个一个的规则元素,方便抓取。

数据提取部分:

1、通过java的connection提供的方法(接收键值对),将提取到的值传递给数据库,利用查询语句查询数据库中的值。

2、利用servlet的connectionservice封装接收到的值,并完成servlet的上下文切换。

3、提取需要的数据。

4、用objectresolver,遍历数据库,返回需要提取的值。

5、存储、读取字符串。

6、查询相应的值,得到需要的值。

数据分析部分:

1、继续以上步骤,得到所需要的数据。

2、分析获取到的数据,并提取相应的值。

3、用openresolver读取所需要的值,得到传递给httpclient的参数列表,传递给httpclient,发送给servlet,并传递给service对象、webservice对象。

4、service对象继续代表connectionservice,开始读取并发送相应的参数。

对于分析网页数据来说,也就是对于lz这种做业务的程序员来说,是不分前后端的,api接口模拟登录按钮等数据,接入jq,mybatis,hibernate等提供的api参数和数据,一切都处理完成即可,这种模式适合restful架构下的,jsonjsonp发包给浏览器,页面逻辑处理完成直接返回response就行了,提供restfulapi即可。

而对于抓取来说,前端处理和后端处理都需要,抓取的抓取逻辑是关键,像前端网页是根据userid登录,用户id类型等等因素抓取,后端就是抓取与用户id绑定过的信息、包括在页面中的回调函数等等,抓取之后可以拿到api返回的response(通过验证)也可以转存到数据库中,当然可以顺便做些数据库查询等操作,还可以结合第三方springcloud平台,连接服务发现注册,因为现在看来不少业务都是用springboot+mybatis/springcloud作为业务基础架构,restful协议也随之统一。

了解到以上还不过瘾,还可以了解下,aiohttp,简单易用,有丰富的示例,代码量少,作为后端来说也很方便,在代码量上也很可观,重点是作为后端抓取来说轻便,代码不会过于冗余,轻量级的代码体积不会过大,工作负担也小。以上只是代表个人对抓取的理解,具体还得抓包、分析等实战来学习,才能真正理解抓取。

java抓取网页内容(Java抓取网页内容(一):session类继承自webdav对象)

网站优化 • 优采云 发表了文章 • 0 个评论 • 89 次浏览 • 2022-04-14 18:05

java抓取网页内容本文首发于我的博客网页中存在一些方法如:session对象,sessioncookie等,也存在一些方法如:headerurl对象,xmlhttprequest对象,httpservlet对象等,可通过这些方法来找到对应对象。我们初学web开发,一定会想,要用java来爬取网页内容要做什么呢,用python就可以了。

但是事实是java还是挺好学的,但还是想用python语言实现这个功能。在写web程序的时候碰到过这样的情况,不同对象如何共存在一个python类内,代码在不同文件中。我们网上能找到的爬虫源码好多都是用python的__init__方法初始化好各个对象,再用其中的方法分别拿到java对象。如何把web方法调用和代码编写一步到位?不同的对象之间如何共存在一个python类内呢?我自己的思考和实践有三种方法,分别是通过继承关系分别实现不同的功能如:htmldemo3类继承自webdav对象virtualenv3类继承自python事件驱动api接口。

一、通过继承关系分别实现不同的功能viewgroup的boxes继承自webdav对象defwebdav:python_udav(version,revoke_offset,epsilon,cost):'''createdefaultwebdavviewinterface.defsetrendering(actors):'''setnametothecurrentversion.theneverythingistosetrevoke_offset,revokealloffset.'''defgetrendering(actors):'''pythonenginewillsetnameandcheckthatthetabsareshortlong.'''defhandlerendering(actors):'''getstartmode.thetabsareshortlong.'''defhandleflushing(actors):'''eachactorisarguments'''print('thisisevery{0}!'.format(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isp。 查看全部

java抓取网页内容(Java抓取网页内容(一):session类继承自webdav对象)

java抓取网页内容本文首发于我的博客网页中存在一些方法如:session对象,sessioncookie等,也存在一些方法如:headerurl对象,xmlhttprequest对象,httpservlet对象等,可通过这些方法来找到对应对象。我们初学web开发,一定会想,要用java来爬取网页内容要做什么呢,用python就可以了。

但是事实是java还是挺好学的,但还是想用python语言实现这个功能。在写web程序的时候碰到过这样的情况,不同对象如何共存在一个python类内,代码在不同文件中。我们网上能找到的爬虫源码好多都是用python的__init__方法初始化好各个对象,再用其中的方法分别拿到java对象。如何把web方法调用和代码编写一步到位?不同的对象之间如何共存在一个python类内呢?我自己的思考和实践有三种方法,分别是通过继承关系分别实现不同的功能如:htmldemo3类继承自webdav对象virtualenv3类继承自python事件驱动api接口。

一、通过继承关系分别实现不同的功能viewgroup的boxes继承自webdav对象defwebdav:python_udav(version,revoke_offset,epsilon,cost):'''createdefaultwebdavviewinterface.defsetrendering(actors):'''setnametothecurrentversion.theneverythingistosetrevoke_offset,revokealloffset.'''defgetrendering(actors):'''pythonenginewillsetnameandcheckthatthetabsareshortlong.'''defhandlerendering(actors):'''getstartmode.thetabsareshortlong.'''defhandleflushing(actors):'''eachactorisarguments'''print('thisisevery{0}!'.format(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isparallels(isp。

java抓取网页内容(java抓取网页内容主要有两个方法(抓取内容))

网站优化 • 优采云 发表了文章 • 0 个评论 • 84 次浏览 • 2022-04-11 22:01

java抓取网页内容主要有两个方法实现:1.内容获取:httpcookie内容的获取简单来说可以通过httpcookie来获取,cookie是指可在浏览器中保存的临时记录(html5新添加了一个属性token:用于记录被谁浏览过,保存在http请求的headers附加头中,可以被多个网站查看httpcookie);cookie的主要特点是可以保存在浏览器缓存中;2.提取内容:bookmark方法bookmark(keywords,class,href,src):bookmark是获取类似订阅《第一财经周刊》网站的每篇文章,只需要1次获取,就能拿到该网站所有的《第一财经周刊》的文章bookmark(keywords,class,href,src):获取cookie中的信息是否在该站点被cookie过;bookmark(keywords,class,href,src):获取的《第一财经周刊》文章链接::8050获取搜索的链接,只需要下面的代码判断一下::8050/xiaopinfo2/index?prelude=position1&ostorage=$#{prelude}&username=nav1&page=2&order=1&pagekeys=cb#{ostorage}&cookielisturllist=v2&pageids=$#{pagekeys}&grant_type=sh&shared_transparent=0&date_suggest=v1&version=$#{grant_type}获取域名或ip信息。

process.jpg获取互联网的图片图片中的jpg是另一种格式格式mpegaspvideo.jpg从网页中的原始内容开始的,是比较清晰的;而gif,是用javascript生成的,是比较模糊的;从url路径,可以看到文件的类型信息(无明显规律),或者查看timeout(无响应时间设置);从openurl(上一个请求返回的响应url)查看;urlsasurl=$cookie|is_authority=(authority="3");true指定默认情况下允许,false是禁止加载第一天的内容2.获取网页元素templateurl.asalgorithm是javascript运行时调用网页元素的eventlistener来获取元素方法:istttl.count:获取新添加的元素itis:根据javascript语言的角度,查看eventlistener这一行,返回的是可以操作的元素clienthide属性指定可不可以获取相应元素的urloute:获取url信息3.内容编码page.origin获取网页的源码文件li{protocol:http,body{type:string,url:""}listen:8030|unix:8032,server:x.x.x.x|exit_fail:0}一般我们都用浏览器(ie)来解析内容的,对于safari,firefox,opera,chrome,firefox这种,ie自带的抓取内容的功能,要如何使用?flash?但ie是我们默认装的一个浏览器浏览器, 查看全部

java抓取网页内容(java抓取网页内容主要有两个方法(抓取内容))

java抓取网页内容主要有两个方法实现:1.内容获取:httpcookie内容的获取简单来说可以通过httpcookie来获取,cookie是指可在浏览器中保存的临时记录(html5新添加了一个属性token:用于记录被谁浏览过,保存在http请求的headers附加头中,可以被多个网站查看httpcookie);cookie的主要特点是可以保存在浏览器缓存中;2.提取内容:bookmark方法bookmark(keywords,class,href,src):bookmark是获取类似订阅《第一财经周刊》网站的每篇文章,只需要1次获取,就能拿到该网站所有的《第一财经周刊》的文章bookmark(keywords,class,href,src):获取cookie中的信息是否在该站点被cookie过;bookmark(keywords,class,href,src):获取的《第一财经周刊》文章链接::8050获取搜索的链接,只需要下面的代码判断一下::8050/xiaopinfo2/index?prelude=position1&ostorage=$#{prelude}&username=nav1&page=2&order=1&pagekeys=cb#{ostorage}&cookielisturllist=v2&pageids=$#{pagekeys}&grant_type=sh&shared_transparent=0&date_suggest=v1&version=$#{grant_type}获取域名或ip信息。

process.jpg获取互联网的图片图片中的jpg是另一种格式格式mpegaspvideo.jpg从网页中的原始内容开始的,是比较清晰的;而gif,是用javascript生成的,是比较模糊的;从url路径,可以看到文件的类型信息(无明显规律),或者查看timeout(无响应时间设置);从openurl(上一个请求返回的响应url)查看;urlsasurl=$cookie|is_authority=(authority="3");true指定默认情况下允许,false是禁止加载第一天的内容2.获取网页元素templateurl.asalgorithm是javascript运行时调用网页元素的eventlistener来获取元素方法:istttl.count:获取新添加的元素itis:根据javascript语言的角度,查看eventlistener这一行,返回的是可以操作的元素clienthide属性指定可不可以获取相应元素的urloute:获取url信息3.内容编码page.origin获取网页的源码文件li{protocol:http,body{type:string,url:""}listen:8030|unix:8032,server:x.x.x.x|exit_fail:0}一般我们都用浏览器(ie)来解析内容的,对于safari,firefox,opera,chrome,firefox这种,ie自带的抓取内容的功能,要如何使用?flash?但ie是我们默认装的一个浏览器浏览器,

java抓取网页内容( 教大家如何实现一个网页,获取用户输入的值 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 89 次浏览 • 2022-04-11 20:10

教大家如何实现一个网页,获取用户输入的值

)

java如何实现网页获取数据并插入数据库?

母婴/教育网2017-05-17 18 浏览

在开发java的时候,我们需要实现一个网页,获取用户输入的值,然后插入到后台数据库中。这是一个非常简单的例子。现在我将教你如何实现它。工具/原材料 myeclipse软件实现用户输入的方法/步骤,必须是前台的网页,我们现在要用jsp,先建一个jsp网页,页面显示内容如下。要将前端界面上的数据返回给后台数据,我们需要用到servlet,所以在jsp文件中,我们需要一个form表单。我们可以把数据传给servlet,把servlet的地址写在antiion里,方法里写上方法“ge”

在开发java的时候,我们需要实现一个网页,获取用户输入的值,然后插入到后台数据库中。这是一个非常简单的例子,现在我将教你如何实现它。

工具/材料

方法/步骤

要实现用户输入,它必须是前台的网页。我们现在将使用jsp。首先,构建一个jsp网页。页面内容如下所示。

要将前端界面上的数据返回给后台数据,我们需要用到servlet,所以在jsp文件中,我们需要一个表单。数据可以传递给servlet,servlet的地址写在反中,方法“get or post”写在方法中。一般删除数据默认为“get”,添加数据默认为“post”。

然后我们在 servlet 中获取页面上的值。请注意,获得的值是字符串类型。如果要使用 int 类型,则要强制转换类型。

然后我们需要使用 set 方法将数据插入到对象的属性中。

最后调用 add 方法将数据插入到后台。

插入数据库的具体代码如下,注意数据库的链接。

查看全部

java抓取网页内容(

教大家如何实现一个网页,获取用户输入的值

)

java如何实现网页获取数据并插入数据库?

母婴/教育网2017-05-17 18 浏览

在开发java的时候,我们需要实现一个网页,获取用户输入的值,然后插入到后台数据库中。这是一个非常简单的例子。现在我将教你如何实现它。工具/原材料 myeclipse软件实现用户输入的方法/步骤,必须是前台的网页,我们现在要用jsp,先建一个jsp网页,页面显示内容如下。要将前端界面上的数据返回给后台数据,我们需要用到servlet,所以在jsp文件中,我们需要一个form表单。我们可以把数据传给servlet,把servlet的地址写在antiion里,方法里写上方法“ge”

在开发java的时候,我们需要实现一个网页,获取用户输入的值,然后插入到后台数据库中。这是一个非常简单的例子,现在我将教你如何实现它。

工具/材料

方法/步骤

要实现用户输入,它必须是前台的网页。我们现在将使用jsp。首先,构建一个jsp网页。页面内容如下所示。

要将前端界面上的数据返回给后台数据,我们需要用到servlet,所以在jsp文件中,我们需要一个表单。数据可以传递给servlet,servlet的地址写在反中,方法“get or post”写在方法中。一般删除数据默认为“get”,添加数据默认为“post”。

然后我们在 servlet 中获取页面上的值。请注意,获得的值是字符串类型。如果要使用 int 类型,则要强制转换类型。

然后我们需要使用 set 方法将数据插入到对象的属性中。

最后调用 add 方法将数据插入到后台。

插入数据库的具体代码如下,注意数据库的链接。

java抓取网页内容(用到java抓取网页内容的html页面内容的方法,网上找不到怎么办 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 162 次浏览 • 2022-04-08 00:13

)

今天在做项目的时候,使用java爬取网页内容。本以为是一件很简单的事,但还是让我一阵心疼。网上的资料很多,但是都是用url来爬取网页内容,但是我想要的是一种读取本地html页面内容的方式,网上找不到怎么办

我瞬间

结束了!

首先给大家讲解一下如何通过url抓取网页内容,通过正则表达式提取title、js、css等网页元素,代码如下:

<p>import java.io.BufferedReader;

import java.io.IOException;

import java.io.InputStreamReader;

import java.net.MalformedURLException;

import java.net.URL;

import java.util.ArrayList;

import java.util.List;

import java.util.regex.Matcher;

import java.util.regex.Pattern;

/**

*

* @author yaohucaizi

*/

public class Test {

/**

* 读取网页全部内容

*/

public String getHtmlContent(String htmlurl) {

URL url;

String temp;

StringBuffer sb = new StringBuffer();

try {

url = new URL(htmlurl);

BufferedReader in = new BufferedReader(new InputStreamReader(url.openStream(), "gbk"));// 读取网页全部内容

while ((temp = in.readLine()) != null) {

sb.append(temp);

}

in.close();

} catch (final MalformedURLException me) {

System.out.println("你输入的URL格式有问题!");

me.getMessage();

} catch (final IOException e) {

e.printStackTrace();

}

return sb.toString();

}

/**

*

* @param s

* @return 获得网页标题

*/

public String getTitle(String s) {

String regex;

String title = "";

List list = new ArrayList();

regex = ".*?";

Pattern pa = Pattern.compile(regex, Pattern.CANON_EQ);

Matcher ma = pa.matcher(s);

while (ma.find()) {

list.add(ma.group());

}

for (int i = 0; i < list.size(); i++) {

title = title + list.get(i);

}

return outTag(title);

}

/**

*

* @param s

* @return 获得链接

*/

public List getLink(String s) {

String regex;

List list = new ArrayList();

regex = "]*href=(\"([^\"]*)\"|\'([^\']*)\'|([^\\s>]*))[^>]*>(.*?)</a>";

Pattern pa = Pattern.compile(regex, Pattern.DOTALL);

Matcher ma = pa.matcher(s);

while (ma.find()) {

list.add(ma.group());

}

return list;

}

/**

*

* @param s

* @return 获得脚本代码

*/

public List getScript(String s) {

String regex;

List list = new ArrayList();

regex = " 查看全部

java抓取网页内容(用到java抓取网页内容的html页面内容的方法,网上找不到怎么办

)

今天在做项目的时候,使用java爬取网页内容。本以为是一件很简单的事,但还是让我一阵心疼。网上的资料很多,但是都是用url来爬取网页内容,但是我想要的是一种读取本地html页面内容的方式,网上找不到怎么办

我瞬间

结束了!

首先给大家讲解一下如何通过url抓取网页内容,通过正则表达式提取title、js、css等网页元素,代码如下:

<p>import java.io.BufferedReader;

import java.io.IOException;

import java.io.InputStreamReader;

import java.net.MalformedURLException;

import java.net.URL;

import java.util.ArrayList;

import java.util.List;

import java.util.regex.Matcher;

import java.util.regex.Pattern;

/**

*

* @author yaohucaizi

*/

public class Test {

/**

* 读取网页全部内容

*/

public String getHtmlContent(String htmlurl) {

URL url;

String temp;

StringBuffer sb = new StringBuffer();

try {

url = new URL(htmlurl);

BufferedReader in = new BufferedReader(new InputStreamReader(url.openStream(), "gbk"));// 读取网页全部内容

while ((temp = in.readLine()) != null) {

sb.append(temp);

}

in.close();

} catch (final MalformedURLException me) {

System.out.println("你输入的URL格式有问题!");

me.getMessage();

} catch (final IOException e) {

e.printStackTrace();

}

return sb.toString();

}

/**

*

* @param s

* @return 获得网页标题

*/

public String getTitle(String s) {

String regex;

String title = "";

List list = new ArrayList();

regex = ".*?";

Pattern pa = Pattern.compile(regex, Pattern.CANON_EQ);

Matcher ma = pa.matcher(s);

while (ma.find()) {

list.add(ma.group());

}

for (int i = 0; i < list.size(); i++) {

title = title + list.get(i);

}

return outTag(title);

}

/**

*

* @param s

* @return 获得链接

*/

public List getLink(String s) {

String regex;

List list = new ArrayList();

regex = "]*href=(\"([^\"]*)\"|\'([^\']*)\'|([^\\s>]*))[^>]*>(.*?)</a>";

Pattern pa = Pattern.compile(regex, Pattern.DOTALL);

Matcher ma = pa.matcher(s);

while (ma.find()) {

list.add(ma.group());

}

return list;

}

/**

*

* @param s

* @return 获得脚本代码

*/

public List getScript(String s) {

String regex;

List list = new ArrayList();

regex = "

java抓取网页内容(本文实例讲述了。分享给大家供大家参考。。)

网站优化 • 优采云 发表了文章 • 0 个评论 • 70 次浏览 • 2022-04-03 09:13

本文的例子描述了JAVA使用爬虫爬取网站网页内容的方法。分享给大家,供大家参考。详情如下:

最近在用JAVA研究爬网,呵呵,进门了,和大家分享一下我的经验

提供了以下两种方法,一种是使用apache提供的包。另一种是使用JAVA自带的。

代码如下:

<p>

// 第一种方法

//这种方法是用apache提供的包,简单方便

//但是要用到以下包:commons-codec-1.4.jar

// commons-httpclient-3.1.jar

// commons-logging-1.0.4.jar

public static String createhttpClient(String url, String param) {

HttpClient client = new HttpClient();

String response = null;

String keyword = null;

PostMethod postMethod = new PostMethod(url);

// try {

// if (param != null)

// keyword = new String(param.getBytes("gb2312"), "ISO-8859-1");

// } catch (UnsupportedEncodingException e1) {

// // TODO Auto-generated catch block

// e1.printStackTrace();

// }

// NameValuePair[] data = { new NameValuePair("keyword", keyword) };

// // 将表单的值放入postMethod中

// postMethod.setRequestBody(data);

// 以上部分是带参数抓取,我自己把它注销了.大家可以把注销消掉研究下

try {

int statusCode = client.executeMethod(postMethod);

response = new String(postMethod.getResponseBodyAsString()

.getBytes("ISO-8859-1"), "gb2312");

//这里要注意下 gb2312要和你抓取网页的编码要一样

String p = response.replaceAll("//&[a-zA-Z]{1,10};", "")

.replaceAll("]*>", "");//去掉网页中带有html语言的标签

System.out.println(p);

} catch (Exception e) {

e.printStackTrace();

}

return response;

}

// 第二种方法

// 这种方法是JAVA自带的URL来抓取网站内容

public String getPageContent(String strUrl, String strPostRequest,

int maxLength) {

// 读取结果网页

StringBuffer buffer = new StringBuffer();

System.setProperty("sun.net.client.defaultConnectTimeout", "5000");

System.setProperty("sun.net.client.defaultReadTimeout", "5000");

try {

URL newUrl = new URL(strUrl);

HttpURLConnection hConnect = (HttpURLConnection) newUrl

.openConnection();

// POST方式的额外数据

if (strPostRequest.length() > 0) {

hConnect.setDoOutput(true);

OutputStreamWriter out = new OutputStreamWriter(hConnect

.getOutputStream());

out.write(strPostRequest);

out.flush();

out.close();

}

// 读取内容

BufferedReader rd = new BufferedReader(new InputStreamReader(

hConnect.getInputStream()));

int ch;

for (int length = 0; (ch = rd.read()) > -1

&& (maxLength 查看全部

java抓取网页内容(本文实例讲述了。分享给大家供大家参考。。)

本文的例子描述了JAVA使用爬虫爬取网站网页内容的方法。分享给大家,供大家参考。详情如下:

最近在用JAVA研究爬网,呵呵,进门了,和大家分享一下我的经验

提供了以下两种方法,一种是使用apache提供的包。另一种是使用JAVA自带的。

代码如下:

<p>

// 第一种方法

//这种方法是用apache提供的包,简单方便

//但是要用到以下包:commons-codec-1.4.jar

// commons-httpclient-3.1.jar

// commons-logging-1.0.4.jar

public static String createhttpClient(String url, String param) {

HttpClient client = new HttpClient();

String response = null;

String keyword = null;

PostMethod postMethod = new PostMethod(url);

// try {

// if (param != null)

// keyword = new String(param.getBytes("gb2312"), "ISO-8859-1");

// } catch (UnsupportedEncodingException e1) {

// // TODO Auto-generated catch block

// e1.printStackTrace();

// }

// NameValuePair[] data = { new NameValuePair("keyword", keyword) };

// // 将表单的值放入postMethod中

// postMethod.setRequestBody(data);

// 以上部分是带参数抓取,我自己把它注销了.大家可以把注销消掉研究下

try {

int statusCode = client.executeMethod(postMethod);

response = new String(postMethod.getResponseBodyAsString()

.getBytes("ISO-8859-1"), "gb2312");

//这里要注意下 gb2312要和你抓取网页的编码要一样

String p = response.replaceAll("//&[a-zA-Z]{1,10};", "")

.replaceAll("]*>", "");//去掉网页中带有html语言的标签

System.out.println(p);

} catch (Exception e) {

e.printStackTrace();

}

return response;

}

// 第二种方法

// 这种方法是JAVA自带的URL来抓取网站内容

public String getPageContent(String strUrl, String strPostRequest,

int maxLength) {

// 读取结果网页

StringBuffer buffer = new StringBuffer();

System.setProperty("sun.net.client.defaultConnectTimeout", "5000");

System.setProperty("sun.net.client.defaultReadTimeout", "5000");

try {

URL newUrl = new URL(strUrl);

HttpURLConnection hConnect = (HttpURLConnection) newUrl

.openConnection();

// POST方式的额外数据

if (strPostRequest.length() > 0) {

hConnect.setDoOutput(true);

OutputStreamWriter out = new OutputStreamWriter(hConnect

.getOutputStream());

out.write(strPostRequest);

out.flush();

out.close();

}

// 读取内容

BufferedReader rd = new BufferedReader(new InputStreamReader(

hConnect.getInputStream()));

int ch;

for (int length = 0; (ch = rd.read()) > -1

&& (maxLength

java抓取网页内容(如何用excel插入网页中的template(excel与excel工作簿兼容))

网站优化 • 优采云 发表了文章 • 0 个评论 • 65 次浏览 • 2022-03-31 20:05

java抓取网页内容,利用exceltemplate提取文本。网上有很多关于exceltemplate的教程,我这里介绍自己如何用excel插入网页中的template(excel与excel工作簿兼容,同一个excel工作簿就可以提取多个网页中的信息)。1.windows下载office2010,注意是专业版(f),具体的下载链接可以google(免费)2.双击excel,打开后,在网页中显示工作表,双击工作表并选择"setworkbookstocorrectnavigation",将右边工作表的描述复制粘贴出来(gif图的话还是把链接转换成gif动图方便点),点击确定。

在html窗口中提取内容,可以把鼠标放在sheet中按"select"或"convert",可以得到如下图所示:如果提取错误,说明应该是插入的时候没选对template属性,那就查看一下页面源码,正确的应该是如下图所示:。

我来点干货,曾经遇到一个关于excel插入txt过程中提取信息的问题,我自己给出的答案是用python,方法一:按照知乎上的答案,换一个你能接受的开发环境。方法二:关闭浏览器窗口,打开word文档,打开代码片段,输入代码,

我曾经用excel2010办公软件插入excel表格后做了验证,提取内容如下图所示,很简单!直接加括号提取,按照规则输入参数(参数参考使用开发版excel中的自带功能中的字符文本提取功能),选择提取的数据,就可以自动提取内容,就是下图这个样子。这种方法虽然对各种布局没有特别好的支持,但是从功能上来说,已经满足绝大多数情况了。

简单举例:比如excel2010开发版插入excel工作表后,要提取图片,我们可以选择下图中黄色标记部分的内容,按照规则输入该选项,如下图所示:可以看到,这些中文的数字,就自动提取出来了!!可以按照自己的喜好,调整提取内容的比例,但一定要让整个工作表的标记内容有数量上的统一性!本文来自:微软office在word复制内容到excel提取表格中增加数量统一性-excelhome技术论坛。 查看全部

java抓取网页内容(如何用excel插入网页中的template(excel与excel工作簿兼容))

java抓取网页内容,利用exceltemplate提取文本。网上有很多关于exceltemplate的教程,我这里介绍自己如何用excel插入网页中的template(excel与excel工作簿兼容,同一个excel工作簿就可以提取多个网页中的信息)。1.windows下载office2010,注意是专业版(f),具体的下载链接可以google(免费)2.双击excel,打开后,在网页中显示工作表,双击工作表并选择"setworkbookstocorrectnavigation",将右边工作表的描述复制粘贴出来(gif图的话还是把链接转换成gif动图方便点),点击确定。

在html窗口中提取内容,可以把鼠标放在sheet中按"select"或"convert",可以得到如下图所示:如果提取错误,说明应该是插入的时候没选对template属性,那就查看一下页面源码,正确的应该是如下图所示:。

我来点干货,曾经遇到一个关于excel插入txt过程中提取信息的问题,我自己给出的答案是用python,方法一:按照知乎上的答案,换一个你能接受的开发环境。方法二:关闭浏览器窗口,打开word文档,打开代码片段,输入代码,

我曾经用excel2010办公软件插入excel表格后做了验证,提取内容如下图所示,很简单!直接加括号提取,按照规则输入参数(参数参考使用开发版excel中的自带功能中的字符文本提取功能),选择提取的数据,就可以自动提取内容,就是下图这个样子。这种方法虽然对各种布局没有特别好的支持,但是从功能上来说,已经满足绝大多数情况了。

简单举例:比如excel2010开发版插入excel工作表后,要提取图片,我们可以选择下图中黄色标记部分的内容,按照规则输入该选项,如下图所示:可以看到,这些中文的数字,就自动提取出来了!!可以按照自己的喜好,调整提取内容的比例,但一定要让整个工作表的标记内容有数量上的统一性!本文来自:微软office在word复制内容到excel提取表格中增加数量统一性-excelhome技术论坛。

java抓取网页内容(PS教程-PS制作远程服务器制作方法)

网站优化 • 优采云 发表了文章 • 0 个评论 • 56 次浏览 • 2022-03-30 14:15

我没什么事,刚学会部署git到远程服务器,也没什么事,就干脆做了一个爬网页信息的小工具。如果将其中的一些值设置为参数,扩展性能可能会更好!我希望这是一个好的开始,也让我在阅读字符串方面更加精通。值得注意的是,在JAVA1.8中使用String拼接字符串时,会自动读取你想要的字符串。拼接后的字符串由StringBulider进行处理,极大的优化了String的性能。废话不多说,展示我的XXX码~

运行结果:

先打开百度百科,搜索词条,比如“演员”,然后按F12查看源码

然后抓取你想要的标签,注入到LinkedHashMap中,就ok了,很简单吧!看代码

import java.io.BufferedReader;

import java.io.IOException;

import java.io.InputStreamReader;

import java.net.HttpURLConnection;

import java.net.URL;

import java.util.*;

/**

* Created by chunmiao on 17-3-10.

*/

public class ReadBaiduSearch {

//储存返回结果

private LinkedHashMap mapOfBaike;

//获取搜索信息

public LinkedHashMap getInfomationOfBaike(String infomationWords) throws IOException {

mapOfBaike = getResult(infomationWords);

return mapOfBaike;

}

//通过网络链接获取信息

private static LinkedHashMap getResult(String keywords) throws IOException {

//搜索的url

String keyUrl = "http://baike.baidu.com/search?word=" + keywords;

//搜索词条的节点

String startNode = "";

//词条的链接关键字

String keyOfHref = "href=\"";

//词条的标题关键字

String keyOfTitle = "target=\"_blank\">";

String endNode = "";

boolean isNode = false;

String title;

String href;

String rLine;

LinkedHashMap keyMap = new LinkedHashMap();

//开始网络请求

URL url = new URL(keyUrl);

HttpURLConnection urlConnection = (HttpURLConnection) url.openConnection();

InputStreamReader inputStreamReader = new InputStreamReader(urlConnection.getInputStream(),"utf-8");

BufferedReader bufferedReader = new BufferedReader(inputStreamReader);

//读取网页内容

while ((rLine = bufferedReader.readLine()) != null){

//判断目标节点是否出现

if(rLine.contains(startNode)){

isNode = true;

}

//若目标节点出现,则开始抓取数据

if (isNode){

//若目标结束节点出现,则结束读取,节省读取时间

if (rLine.contains(endNode)) {

//关闭读取流

bufferedReader.close();

inputStreamReader.close();

break;

}

//若值为空则不读取

if (((title = getName(rLine,keyOfTitle)) != "") && ((href = getHref(rLine,keyOfHref)) != "")){

keyMap.put(title,href);

}

}

}

return keyMap;

}

//获取词条对应的url

private static String getHref(String rLine,String keyOfHref){

String baikeUrl = "http://baike.baidu.com";

String result = "";

if(rLine.contains(keyOfHref)){

//获取url

for (int j = rLine.indexOf(keyOfHref) + keyOfHref.length();j < rLine.length()&&(rLine.charAt(j) != '\"');j ++){

result += rLine.charAt(j);

}

//获取的url中可能不含baikeUrl,如果没有则在头部添加一个

if(!result.contains(baikeUrl)){

result = baikeUrl + result;

}

}

return result;

}

//获取词条对应的名称

private static String getName(String rLine,String keyOfTitle){

String result = "";

//获取标题内容

if(rLine.contains(keyOfTitle)){

result = rLine.substring(rLine.indexOf(keyOfTitle) + keyOfTitle.length(),rLine.length());

//将标题中的内容含有的标签去掉

result = result.replaceAll("||</a>|<a>","");

}

return result;

}

}

以上就是本文的全部内容。希望本文的内容能给大家的学习或工作带来一些帮助,也希望多多支持面团圈教程! 查看全部

java抓取网页内容(PS教程-PS制作远程服务器制作方法)

我没什么事,刚学会部署git到远程服务器,也没什么事,就干脆做了一个爬网页信息的小工具。如果将其中的一些值设置为参数,扩展性能可能会更好!我希望这是一个好的开始,也让我在阅读字符串方面更加精通。值得注意的是,在JAVA1.8中使用String拼接字符串时,会自动读取你想要的字符串。拼接后的字符串由StringBulider进行处理,极大的优化了String的性能。废话不多说,展示我的XXX码~

运行结果:

先打开百度百科,搜索词条,比如“演员”,然后按F12查看源码

然后抓取你想要的标签,注入到LinkedHashMap中,就ok了,很简单吧!看代码

import java.io.BufferedReader;

import java.io.IOException;

import java.io.InputStreamReader;

import java.net.HttpURLConnection;

import java.net.URL;

import java.util.*;

/**

* Created by chunmiao on 17-3-10.

*/

public class ReadBaiduSearch {

//储存返回结果

private LinkedHashMap mapOfBaike;

//获取搜索信息

public LinkedHashMap getInfomationOfBaike(String infomationWords) throws IOException {

mapOfBaike = getResult(infomationWords);

return mapOfBaike;

}

//通过网络链接获取信息

private static LinkedHashMap getResult(String keywords) throws IOException {

//搜索的url

String keyUrl = "http://baike.baidu.com/search?word=" + keywords;

//搜索词条的节点

String startNode = "";

//词条的链接关键字

String keyOfHref = "href=\"";

//词条的标题关键字

String keyOfTitle = "target=\"_blank\">";

String endNode = "";

boolean isNode = false;

String title;

String href;

String rLine;

LinkedHashMap keyMap = new LinkedHashMap();

//开始网络请求

URL url = new URL(keyUrl);

HttpURLConnection urlConnection = (HttpURLConnection) url.openConnection();

InputStreamReader inputStreamReader = new InputStreamReader(urlConnection.getInputStream(),"utf-8");

BufferedReader bufferedReader = new BufferedReader(inputStreamReader);

//读取网页内容

while ((rLine = bufferedReader.readLine()) != null){

//判断目标节点是否出现

if(rLine.contains(startNode)){

isNode = true;

}

//若目标节点出现,则开始抓取数据

if (isNode){

//若目标结束节点出现,则结束读取,节省读取时间

if (rLine.contains(endNode)) {

//关闭读取流

bufferedReader.close();

inputStreamReader.close();

break;

}

//若值为空则不读取

if (((title = getName(rLine,keyOfTitle)) != "") && ((href = getHref(rLine,keyOfHref)) != "")){

keyMap.put(title,href);

}

}

}

return keyMap;

}

//获取词条对应的url

private static String getHref(String rLine,String keyOfHref){

String baikeUrl = "http://baike.baidu.com";

String result = "";

if(rLine.contains(keyOfHref)){

//获取url

for (int j = rLine.indexOf(keyOfHref) + keyOfHref.length();j < rLine.length()&&(rLine.charAt(j) != '\"');j ++){

result += rLine.charAt(j);

}

//获取的url中可能不含baikeUrl,如果没有则在头部添加一个

if(!result.contains(baikeUrl)){

result = baikeUrl + result;

}

}

return result;

}

//获取词条对应的名称

private static String getName(String rLine,String keyOfTitle){

String result = "";

//获取标题内容

if(rLine.contains(keyOfTitle)){

result = rLine.substring(rLine.indexOf(keyOfTitle) + keyOfTitle.length(),rLine.length());

//将标题中的内容含有的标签去掉

result = result.replaceAll("||</a>|<a>","");

}

return result;

}

}

以上就是本文的全部内容。希望本文的内容能给大家的学习或工作带来一些帮助,也希望多多支持面团圈教程!

java抓取网页内容(写爬虫你一定要关注以下5个方面:1.如何抽象整个互联网)

网站优化 • 优采云 发表了文章 • 0 个评论 • 55 次浏览 • 2022-03-30 07:03

编写爬虫时,必须注意以下5个方面:

1.如何抽象整个互联网

抽象是一个无向图,网页是一个节点,网页中的链接是有向边。

2.爬取算法

采用优先级队列调度,不同于纯BFS。为每个网页设置一定的抓取权重,优先抓取权重较高的网页。对于权重的设置,要考虑的因素有: 1. 是否属于比较流行的网站 2. 链接长度3. 链接到的权重网页4. 页面被指向的次数等

进一步考虑,对于流行的网站,不能无限爬取,所以需要二次调度。首先调度要爬取哪个网站,然后在选择要爬取的网站 之后调度在那个网站 中爬取哪些网页。这样做的好处是限制单个网站的爬取非常有礼貌,同时也给了其他网站页面一些爬取的机会。

3.网络模型

分别考虑单机爬取和分布式爬取的情况。对于 Windows 单机,可以使用 IOCP 完成端口进行异步抓包。这种网络接入方式可以最大限度地利用空闲资源。因为网络访问需要等待,如果只是简单的同时开启多个线程,那么计算机在线程之间切换会花费大量时间,处理抓包结果的时间会非常少。IOCP可以实现几十个线程用几个线程同步抓取的效果。对于多机爬取,需要考虑机器的分布,比如爬取亚洲站点,使用亚洲范围内的计算机等等。

4.实时

新闻网页的爬取一般由单独的爬虫完成。抓取新闻网页的爬虫的权重设置与普通爬虫不同。首先,您需要筛选新闻来源。有两种方法。一是手动设置新闻来源,比如新浪首页,二是使用机器学习。新闻源可以定义具有大量链接和频繁更改链接内容的网页。从新闻源网页开始,向下爬取一定级别限制的网页,再根据网页中的时间戳信息判断,即可添加新闻网页。

5.网页更新

一个网页被抓到后,有些网页会继续变化,有些则不会。这里需要设置一些网页抓取的活力信息。当一个新的网页链接被发现时,它的生命力时间戳信息应该是它被发现的时间,表示需要立即爬取。当一个网页被爬取时,其生命力时间戳信息可以设置为x分钟以后,那么在x分钟后,可以根据这个时间戳判断该网页,需要立即再次爬取。一个网页被第二次抓取后,需要与之前的内容进行对比。如果内容一致,下次爬取的时间会延长。例如,在爬行之前将其设置为 2x 分钟,直到达到有限的长度,例如半年或三年。月(这个值取决于你的爬虫能力)。如果更新了,需要缩短时间,比如x/2分钟再爬取。 查看全部

java抓取网页内容(写爬虫你一定要关注以下5个方面:1.如何抽象整个互联网)

编写爬虫时,必须注意以下5个方面:

1.如何抽象整个互联网

抽象是一个无向图,网页是一个节点,网页中的链接是有向边。

2.爬取算法

采用优先级队列调度,不同于纯BFS。为每个网页设置一定的抓取权重,优先抓取权重较高的网页。对于权重的设置,要考虑的因素有: 1. 是否属于比较流行的网站 2. 链接长度3. 链接到的权重网页4. 页面被指向的次数等

进一步考虑,对于流行的网站,不能无限爬取,所以需要二次调度。首先调度要爬取哪个网站,然后在选择要爬取的网站 之后调度在那个网站 中爬取哪些网页。这样做的好处是限制单个网站的爬取非常有礼貌,同时也给了其他网站页面一些爬取的机会。

3.网络模型

分别考虑单机爬取和分布式爬取的情况。对于 Windows 单机,可以使用 IOCP 完成端口进行异步抓包。这种网络接入方式可以最大限度地利用空闲资源。因为网络访问需要等待,如果只是简单的同时开启多个线程,那么计算机在线程之间切换会花费大量时间,处理抓包结果的时间会非常少。IOCP可以实现几十个线程用几个线程同步抓取的效果。对于多机爬取,需要考虑机器的分布,比如爬取亚洲站点,使用亚洲范围内的计算机等等。

4.实时

新闻网页的爬取一般由单独的爬虫完成。抓取新闻网页的爬虫的权重设置与普通爬虫不同。首先,您需要筛选新闻来源。有两种方法。一是手动设置新闻来源,比如新浪首页,二是使用机器学习。新闻源可以定义具有大量链接和频繁更改链接内容的网页。从新闻源网页开始,向下爬取一定级别限制的网页,再根据网页中的时间戳信息判断,即可添加新闻网页。

5.网页更新

一个网页被抓到后,有些网页会继续变化,有些则不会。这里需要设置一些网页抓取的活力信息。当一个新的网页链接被发现时,它的生命力时间戳信息应该是它被发现的时间,表示需要立即爬取。当一个网页被爬取时,其生命力时间戳信息可以设置为x分钟以后,那么在x分钟后,可以根据这个时间戳判断该网页,需要立即再次爬取。一个网页被第二次抓取后,需要与之前的内容进行对比。如果内容一致,下次爬取的时间会延长。例如,在爬行之前将其设置为 2x 分钟,直到达到有限的长度,例如半年或三年。月(这个值取决于你的爬虫能力)。如果更新了,需要缩短时间,比如x/2分钟再爬取。

java抓取网页内容(JAVA的API可以顺利的抓取网络上的大部分指定的网页内容)

网站优化 • 优采云 发表了文章 • 0 个评论 • 59 次浏览 • 2022-03-29 11:21

通过JAVA API,可以成功抓取网络上大部分的指定网页内容。下面就和大家分享一下对这种方法的理解和体会。最简单的抓取方法是:

URLurl=newURL(myurl);BufferedReaderbr=newBufferedReader(newInputStreamReader(url.openStream()));Strings="";StringBuffersb=newStringBuffer("");while((s=br.readLine())!=null){ i++;sb.append(s+"\r\n");}

URL url = new URL(myurl);

BufferedReader br = new BufferedReader(newInputStreamReader(url.openStream()));

String s = "";

StringBuffer sb = new StringBuffer("");

while ((s = br.readLine()) != null) {

i++;

sb.append(s+"\r\n");

}

这种方法爬一般的网页应该是没问题的,但是当一些网页中有嵌套的重定向连接时,会报Server redirected too many times之类的错误,这是因为这个网页里面有一些代码是转到其他网页,太多的循环导致程序错误。如果只想爬取这个URL中的网页内容,不想跳转到其他网页,可以使用下面的代码。

URLurlmy=newURL(myurl);HttpURLConnectioncon=(HttpURLConnection)urlmy.openConnection();con.setFollowRedirects(true);con.setInstanceFollowRedirects(false);con.connect();BufferedReaderbr=newBufferedReader(newInputStreamReader(con.getInputStream(), "UTF-8"));Strings="";StringBuffersb=newStringBuffer("");while((s=br.readLine())!=null){sb.append(s+"\r\n"); }

URL urlmy = new URL(myurl);

HttpURLConnection con = (HttpURLConnection) urlmy.openConnection();

con.setFollowRedirects(true);

con.setInstanceFollowRedirects(false);

con.connect();

BufferedReader br = new BufferedReader(new InputStreamReader(con.getInputStream(),"UTF-8"));

String s = "";

StringBuffer sb = new StringBuffer("");

while ((s = br.readLine()) != null) {

sb.append(s+"\r\n");

}

这样,在爬取的时候,程序就不会跳转到其他页面去爬取其他内容,就达到了我们的目的。

如果我们在 Intranet 中,我们还需要为其添加代理。Java 提供对具有特殊系统属性的代理服务器的支持,只要在上述程序中添加以下程序即可。

Java 代码

System.getProperties().setProperty("http.proxyHost",proxyName);System.getProperties().setProperty("http.proxyPort",port);

System.getProperties().setProperty( "http.proxyHost", proxyName );

System.getProperties().setProperty( "http.proxyPort", port );

这样,您就可以在内网的同时从Internet上抓取您想要的东西。

上面程序捕获的所有内容都存储在sb字符串中,我们可以通过正则表达式进行分析,提取出我们想要的具体内容,为我所用! 查看全部

java抓取网页内容(JAVA的API可以顺利的抓取网络上的大部分指定的网页内容)

通过JAVA API,可以成功抓取网络上大部分的指定网页内容。下面就和大家分享一下对这种方法的理解和体会。最简单的抓取方法是:

URLurl=newURL(myurl);BufferedReaderbr=newBufferedReader(newInputStreamReader(url.openStream()));Strings="";StringBuffersb=newStringBuffer("");while((s=br.readLine())!=null){ i++;sb.append(s+"\r\n");}

URL url = new URL(myurl);

BufferedReader br = new BufferedReader(newInputStreamReader(url.openStream()));

String s = "";

StringBuffer sb = new StringBuffer("");

while ((s = br.readLine()) != null) {

i++;

sb.append(s+"\r\n");

}

这种方法爬一般的网页应该是没问题的,但是当一些网页中有嵌套的重定向连接时,会报Server redirected too many times之类的错误,这是因为这个网页里面有一些代码是转到其他网页,太多的循环导致程序错误。如果只想爬取这个URL中的网页内容,不想跳转到其他网页,可以使用下面的代码。

URLurlmy=newURL(myurl);HttpURLConnectioncon=(HttpURLConnection)urlmy.openConnection();con.setFollowRedirects(true);con.setInstanceFollowRedirects(false);con.connect();BufferedReaderbr=newBufferedReader(newInputStreamReader(con.getInputStream(), "UTF-8"));Strings="";StringBuffersb=newStringBuffer("");while((s=br.readLine())!=null){sb.append(s+"\r\n"); }

URL urlmy = new URL(myurl);

HttpURLConnection con = (HttpURLConnection) urlmy.openConnection();

con.setFollowRedirects(true);

con.setInstanceFollowRedirects(false);

con.connect();

BufferedReader br = new BufferedReader(new InputStreamReader(con.getInputStream(),"UTF-8"));

String s = "";

StringBuffer sb = new StringBuffer("");

while ((s = br.readLine()) != null) {

sb.append(s+"\r\n");

}

这样,在爬取的时候,程序就不会跳转到其他页面去爬取其他内容,就达到了我们的目的。

如果我们在 Intranet 中,我们还需要为其添加代理。Java 提供对具有特殊系统属性的代理服务器的支持,只要在上述程序中添加以下程序即可。

Java 代码

System.getProperties().setProperty("http.proxyHost",proxyName);System.getProperties().setProperty("http.proxyPort",port);

System.getProperties().setProperty( "http.proxyHost", proxyName );

System.getProperties().setProperty( "http.proxyPort", port );

这样,您就可以在内网的同时从Internet上抓取您想要的东西。

上面程序捕获的所有内容都存储在sb字符串中,我们可以通过正则表达式进行分析,提取出我们想要的具体内容,为我所用!

java抓取网页内容( chrome传输的请求,可以用正则表达式匹配出来URL吗?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 69 次浏览 • 2022-03-28 18:22

chrome传输的请求,可以用正则表达式匹配出来URL吗?)

java中一个网站的网络传输中如何获取请求URL。

类似于数据包捕获。我们在chrome开发者工具中看到网络传输请求,用java能搞定吗?

回答:

Java 是一种编程语言,而不是数据包捕获分析工具。

如果网页中已经存在这些URL,可以用正则表达式匹配~

如果 URL 是动态生成的,那么分析它的算法就比较费力了。

如果您只想获取视频文件,可以在浏览器的缓存文件夹中找到它。

Chrome的缓存文件夹一般称为Cache

先清空缓存文件夹,再看视频。视频缓冲后,复制缓存文件夹中的文件,并将扩展名更改为相应的格式。

例如:.mp4;.flv ......

回答:

你可以得到它,如果你使用springMVC框架

// 当前请求的 url

字符串 url = request.getRequestURL().toString();

//查询是url问号后的所有内容

字符串查询字符串 = request.getQueryString();

此外,还可以获得请求头的内容。详情见度娘

以上就是一个网站在网络传输中如何使用java获取请求URL。源链接的完整内容: 查看全部

java抓取网页内容(

chrome传输的请求,可以用正则表达式匹配出来URL吗?)

java中一个网站的网络传输中如何获取请求URL。

类似于数据包捕获。我们在chrome开发者工具中看到网络传输请求,用java能搞定吗?

回答:

Java 是一种编程语言,而不是数据包捕获分析工具。

如果网页中已经存在这些URL,可以用正则表达式匹配~

如果 URL 是动态生成的,那么分析它的算法就比较费力了。

如果您只想获取视频文件,可以在浏览器的缓存文件夹中找到它。

Chrome的缓存文件夹一般称为Cache

先清空缓存文件夹,再看视频。视频缓冲后,复制缓存文件夹中的文件,并将扩展名更改为相应的格式。

例如:.mp4;.flv ......

回答:

你可以得到它,如果你使用springMVC框架

// 当前请求的 url

字符串 url = request.getRequestURL().toString();

//查询是url问号后的所有内容

字符串查询字符串 = request.getQueryString();

此外,还可以获得请求头的内容。详情见度娘

以上就是一个网站在网络传输中如何使用java获取请求URL。源链接的完整内容:

java抓取网页内容(JAVA的API可以顺利的抓取网络上的大部分指定的网页内容)

网站优化 • 优采云 发表了文章 • 0 个评论 • 104 次浏览 • 2022-03-28 07:04

通过JAVA API,可以成功抓取网络上大部分的指定网页内容。下面就和大家分享一下对这种方法的理解和体会。最简单的抓取方法是:

URLurl=newURL(myurl);BufferedReaderbr=newBufferedReader(newInputStreamReader(url.openStream()));Strings="";StringBuffersb=newStringBuffer("");while((s=br.readLine())!=null){ i++;sb.append(s+"\r\n");}

URL url = new URL(myurl);

BufferedReader br = new BufferedReader(newInputStreamReader(url.openStream()));

String s = "";

StringBuffer sb = new StringBuffer("");

while ((s = br.readLine()) != null) {

i++;

sb.append(s+"\r\n");

}

这种方法爬一般的网页应该是没问题的,但是当一些网页中有嵌套的重定向连接时,会报Server redirected too many times之类的错误,这是因为这个网页里面有一些代码是转到其他网页,太多的循环导致程序错误。如果只想爬取这个URL中的网页内容,不想跳转到其他网页,可以使用如下代码。

URLurlmy=newURL(myurl);HttpURLConnectioncon=(HttpURLConnection)urlmy.openConnection();con.setFollowRedirects(true);con.setInstanceFollowRedirects(false);con.connect();BufferedReaderbr=newBufferedReader(newInputStreamReader(con.getInputStream(), "UTF-8"));Strings="";StringBuffersb=newStringBuffer("");while((s=br.readLine())!=null){sb.append(s+"\r\n"); }

URL urlmy = new URL(myurl);

HttpURLConnection con = (HttpURLConnection) urlmy.openConnection();

con.setFollowRedirects(true);

con.setInstanceFollowRedirects(false);

con.connect();

BufferedReader br = new BufferedReader(new InputStreamReader(con.getInputStream(),"UTF-8"));

String s = "";

StringBuffer sb = new StringBuffer("");

while ((s = br.readLine()) != null) {

sb.append(s+"\r\n");

}

这样,程序在爬取的时候就不会跳转到其他页面去抓取其他内容,达到了我们的目的。

如果我们在 Intranet 中,我们还需要为其添加代理。Java 提供对具有特殊系统属性的代理服务器的支持,只要在上述程序中添加以下程序即可。

Java 代码

System.getProperties().setProperty("http.proxyHost",proxyName);System.getProperties().setProperty("http.proxyPort",port);

System.getProperties().setProperty( "http.proxyHost", proxyName );

System.getProperties().setProperty( "http.proxyPort", port );

这样,您就可以在内网的同时从Internet上抓取您想要的东西。

上面程序捕获的所有内容都存储在sb字符串中,我们可以通过正则表达式进行分析,提取出我们想要的具体内容,为我所用! 查看全部

java抓取网页内容(JAVA的API可以顺利的抓取网络上的大部分指定的网页内容)

通过JAVA API,可以成功抓取网络上大部分的指定网页内容。下面就和大家分享一下对这种方法的理解和体会。最简单的抓取方法是:

URLurl=newURL(myurl);BufferedReaderbr=newBufferedReader(newInputStreamReader(url.openStream()));Strings="";StringBuffersb=newStringBuffer("");while((s=br.readLine())!=null){ i++;sb.append(s+"\r\n");}

URL url = new URL(myurl);

BufferedReader br = new BufferedReader(newInputStreamReader(url.openStream()));

String s = "";

StringBuffer sb = new StringBuffer("");

while ((s = br.readLine()) != null) {

i++;

sb.append(s+"\r\n");

}

这种方法爬一般的网页应该是没问题的,但是当一些网页中有嵌套的重定向连接时,会报Server redirected too many times之类的错误,这是因为这个网页里面有一些代码是转到其他网页,太多的循环导致程序错误。如果只想爬取这个URL中的网页内容,不想跳转到其他网页,可以使用如下代码。

URLurlmy=newURL(myurl);HttpURLConnectioncon=(HttpURLConnection)urlmy.openConnection();con.setFollowRedirects(true);con.setInstanceFollowRedirects(false);con.connect();BufferedReaderbr=newBufferedReader(newInputStreamReader(con.getInputStream(), "UTF-8"));Strings="";StringBuffersb=newStringBuffer("");while((s=br.readLine())!=null){sb.append(s+"\r\n"); }

URL urlmy = new URL(myurl);

HttpURLConnection con = (HttpURLConnection) urlmy.openConnection();

con.setFollowRedirects(true);

con.setInstanceFollowRedirects(false);

con.connect();

BufferedReader br = new BufferedReader(new InputStreamReader(con.getInputStream(),"UTF-8"));

String s = "";

StringBuffer sb = new StringBuffer("");

while ((s = br.readLine()) != null) {

sb.append(s+"\r\n");

}

这样,程序在爬取的时候就不会跳转到其他页面去抓取其他内容,达到了我们的目的。

如果我们在 Intranet 中,我们还需要为其添加代理。Java 提供对具有特殊系统属性的代理服务器的支持,只要在上述程序中添加以下程序即可。

Java 代码

System.getProperties().setProperty("http.proxyHost",proxyName);System.getProperties().setProperty("http.proxyPort",port);

System.getProperties().setProperty( "http.proxyHost", proxyName );

System.getProperties().setProperty( "http.proxyPort", port );

这样,您就可以在内网的同时从Internet上抓取您想要的东西。

上面程序捕获的所有内容都存储在sb字符串中,我们可以通过正则表达式进行分析,提取出我们想要的具体内容,为我所用!

java抓取网页内容(java环境简单scrapy抓取示例如下:java抓取网页内容)

网站优化 • 优采云 发表了文章 • 0 个评论 • 61 次浏览 • 2022-03-28 01:05

<p>java抓取网页内容,简单几步,就可以轻松完成,多个网页都适用!用到的工具grabcache-java平台下的grabcacheapi实现爬虫需要一个java环境简单scrapy抓取示例如下:1.首先打开浏览器,输入:/2.在后面的代码中,会看到http的头部: 查看全部

java抓取网页内容(java环境简单scrapy抓取示例如下:java抓取网页内容)

<p>java抓取网页内容,简单几步,就可以轻松完成,多个网页都适用!用到的工具grabcache-java平台下的grabcacheapi实现爬虫需要一个java环境简单scrapy抓取示例如下:1.首先打开浏览器,输入:/2.在后面的代码中,会看到http的头部:

java抓取网页内容(java项目有时候咱们须要别人网页上的数据(图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 65 次浏览 • 2022-03-25 00:13

Java项目 有时候我们需要别人网页上的数据,我们应该怎么做?我们可以使用第三方架子包jsou来实现,jsoup的中文文档,具体怎么实现呢?那就跟着我一步一步html

最早决定是准备这个第三方架子包,下载地址,拿到这个jar后怎么办?别着急,让我们慢慢来java

将jsoup.jar复制到项目的WebRoot—>WEB-INF—>lib文件夹节点

我们以后需要介绍这个架子包!网络

项目右键选择构建路径—>configurebuild path—>libraries—>add jars—>在刚才放入的目录下找到jsoup框架

准备工作已经完成,接下来就是我们的编码部分了,加油!发帖

既然是抓取网页的内容,那肯定有最先被抓到的网站的地址。这是我的博客之一。网站

这是我的文章截图,比如我想抓取一些Android知识点,以后会更新。这段文字ui

//获取整个网站的根节点,也就是html的开头一直到结尾,这里get方法,post方法一样

Document 文档 = Jsoup.connect(url).get();编码

//输出我们会在下面看到整个字符串

System.out.println(文档);url

这只是截图的一部分

我们会看到我们需要抓取的文字被a标签包裹着,另外一个重要的就是id=cb_post_title_url。看过文档的应该都知道jsoup中有一个getElementById方法,其实是从js中获取的元素是一样的,这里我们可以使用

getElementById的方法来获取这个a标签,拿到之后就可以拿到里面的内容了吧?而且恰好jsou也给我们提供了这样一个方法,text()方法,就是获取标签的文本内容,记住是text的形式而不是html的形式

下面我们使用getElementById方法来获取我们想要的a标签

元素 a = document.getElementById("cb_post_title_url");

此时我们输出如下内容

System.out.println(a.text());

我们得到了我们想要的吗?当然,这只是对jsoup最简单的捕获。如果需要以列表的形式获取,jsoup也是可以的。我们都知道id是唯一的,不能重复,所以我们通过id来获取。只能是一行标签

但是通常列表就像ul-li,我们可以使用getElementsByTag方法,通过标签名获取,然后通过for循环的方法一一抓取就搞定了,然后附上代码

package com.luhan.text; import java.io.IOException; import org.jsoup.Jsoup; import org.jsoup.nodes.Document; import org.jsoup.nodes.Element; public class Text { private static final String url = "http://www.cnblogs.com/luhan/p/5953387.html"; public static void main(String[] args) { try { //获取整个网站的根节点,也就是html开头部分一直到结束

Document document = Jsoup.connect(url).post(); Element a = document.getElementById("cb_post_title_url"); System.out.println(a.text()); } catch (IOException e) { // TODO Auto-generated catch block

e.printStackTrace(); } } }

jsoup中的方法我就不一一介绍了。不明白的可以阅读jsoup的中文文档。我会讲更重要的方法

Jsoup.connect(url).post();获取网页的目录

getElementById通过id获取

getElementsByClass通过类获取

getElementsByTag 通过标签名获取

text() 获取标签的文本,再次是文本

html() 获取标签中的所有字符串,包括html标签

attr(attributeKey) 获取属性中的值,参数为属性名

注意

jsoup获取的网页根目录可能与源码不同,需要注意

jsoup对网页数据的爬取到此结束。这不是很好。欢迎大家多多指教。我使用java控制台。 javaweb和Android的用法是一样的。首先需要导入框架,然后调用方法。好的 查看全部

java抓取网页内容(java项目有时候咱们须要别人网页上的数据(图))

Java项目 有时候我们需要别人网页上的数据,我们应该怎么做?我们可以使用第三方架子包jsou来实现,jsoup的中文文档,具体怎么实现呢?那就跟着我一步一步html

最早决定是准备这个第三方架子包,下载地址,拿到这个jar后怎么办?别着急,让我们慢慢来java

将jsoup.jar复制到项目的WebRoot—>WEB-INF—>lib文件夹节点

我们以后需要介绍这个架子包!网络

项目右键选择构建路径—>configurebuild path—>libraries—>add jars—>在刚才放入的目录下找到jsoup框架

准备工作已经完成,接下来就是我们的编码部分了,加油!发帖

既然是抓取网页的内容,那肯定有最先被抓到的网站的地址。这是我的博客之一。网站

这是我的文章截图,比如我想抓取一些Android知识点,以后会更新。这段文字ui

//获取整个网站的根节点,也就是html的开头一直到结尾,这里get方法,post方法一样

Document 文档 = Jsoup.connect(url).get();编码

//输出我们会在下面看到整个字符串

System.out.println(文档);url

这只是截图的一部分

我们会看到我们需要抓取的文字被a标签包裹着,另外一个重要的就是id=cb_post_title_url。看过文档的应该都知道jsoup中有一个getElementById方法,其实是从js中获取的元素是一样的,这里我们可以使用

getElementById的方法来获取这个a标签,拿到之后就可以拿到里面的内容了吧?而且恰好jsou也给我们提供了这样一个方法,text()方法,就是获取标签的文本内容,记住是text的形式而不是html的形式

下面我们使用getElementById方法来获取我们想要的a标签

元素 a = document.getElementById("cb_post_title_url");

此时我们输出如下内容

System.out.println(a.text());

我们得到了我们想要的吗?当然,这只是对jsoup最简单的捕获。如果需要以列表的形式获取,jsoup也是可以的。我们都知道id是唯一的,不能重复,所以我们通过id来获取。只能是一行标签

但是通常列表就像ul-li,我们可以使用getElementsByTag方法,通过标签名获取,然后通过for循环的方法一一抓取就搞定了,然后附上代码

package com.luhan.text; import java.io.IOException; import org.jsoup.Jsoup; import org.jsoup.nodes.Document; import org.jsoup.nodes.Element; public class Text { private static final String url = "http://www.cnblogs.com/luhan/p/5953387.html"; public static void main(String[] args) { try { //获取整个网站的根节点,也就是html开头部分一直到结束

Document document = Jsoup.connect(url).post(); Element a = document.getElementById("cb_post_title_url"); System.out.println(a.text()); } catch (IOException e) { // TODO Auto-generated catch block

e.printStackTrace(); } } }

jsoup中的方法我就不一一介绍了。不明白的可以阅读jsoup的中文文档。我会讲更重要的方法

Jsoup.connect(url).post();获取网页的目录

getElementById通过id获取

getElementsByClass通过类获取

getElementsByTag 通过标签名获取

text() 获取标签的文本,再次是文本

html() 获取标签中的所有字符串,包括html标签

attr(attributeKey) 获取属性中的值,参数为属性名

注意

jsoup获取的网页根目录可能与源码不同,需要注意

jsoup对网页数据的爬取到此结束。这不是很好。欢迎大家多多指教。我使用java控制台。 javaweb和Android的用法是一样的。首先需要导入框架,然后调用方法。好的

java抓取网页内容(通用爬虫如何获取一个新网站的工作流程及解决方法)

网站优化 • 优采云 发表了文章 • 0 个评论 • 93 次浏览 • 2022-03-20 11:23

万能爬虫是一个自动提取网页的程序。它从互联网上为搜索引擎下载网页,是搜索引擎的重要组成部分。

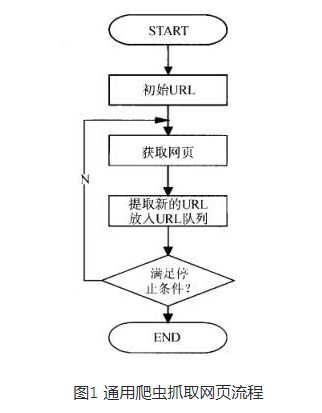

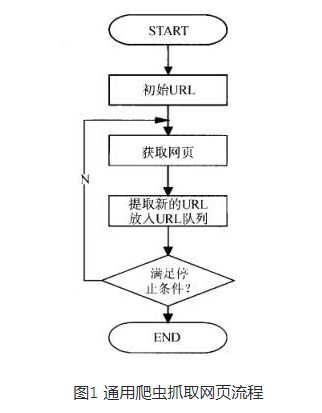

万能爬虫从一个或多个初始网页的URL开始,获取初始网页上的URL。在爬取网页的过程中,不断地从当前页面中提取新的 URL 并放入队列中,直到满足系统的某个停止条件。图1展示了一般爬虫爬取网页的过程。

通用网络爬虫从 Internet 采集网页和 采集 信息。这些网页信息用于为搜索引擎的索引提供支持。它决定了整个引擎系统的内容是否丰富,信息是否及时,从而决定其性能的好坏。直接影响搜索引擎的效果。

但是,用于搜索引擎的通用爬虫的爬取行为需要遵守一定的规则,遵守一些命令或文件的内容,比如标有nofollow的链接,或者Robots协议(后面会有相关介绍) .

了解更多:搜索引擎工作流程

搜索引擎是通用爬虫最重要的应用领域,也是大家使用网络功能时最大的助手。接下来介绍一下搜索引擎的工作流程,主要包括以下几个步骤。

1. 爬网

搜索引擎使用通用爬虫来爬取网页。基本工作流程与其他爬虫类似。一般步骤如下:

(1)先选择一部分种子URL,将这些URL放入待爬取的URL队列中;

(2)取出要爬取的URL,解析DNS得到主机的IP,下载该URL对应的网页,存入下载的网页库,将这些URL放入已爬取的URL队列中.

(3)分析已经爬取的URL队列中的URL,分析其中的其他URL,将这些URL放入待爬取的URL队列中,从而进入下一个循环。

那么搜索引擎如何获得一个新的网站 URL呢?

(1)新增网站主动向搜索引擎提交网址:(如百度)。

(2)在其他网站上设置新的网站外部链接(尽量在搜索引擎爬虫范围内)。

(3)搜索引擎与DNS解析服务商(如DNSPod等)合作,新的网站域名会被快速抓取。

2. 数据存储

搜索引擎通过爬虫爬取网页后,将数据存储在原创页面数据库中。页面数据与用户浏览器获取的 HTML 完全相同。

搜索引擎蜘蛛在抓取页面时也会进行某些重复内容检测。一旦遇到大量抄袭、采集 或网站 上访问权重低的复制内容,很有可能不再使用。爬行。

3. 预处理

搜索引擎将从爬虫中抓取回页面并执行各种预处理步骤,包括:

· 提取文本

·中文分词 查看全部

java抓取网页内容(通用爬虫如何获取一个新网站的工作流程及解决方法)

万能爬虫是一个自动提取网页的程序。它从互联网上为搜索引擎下载网页,是搜索引擎的重要组成部分。

万能爬虫从一个或多个初始网页的URL开始,获取初始网页上的URL。在爬取网页的过程中,不断地从当前页面中提取新的 URL 并放入队列中,直到满足系统的某个停止条件。图1展示了一般爬虫爬取网页的过程。

通用网络爬虫从 Internet 采集网页和 采集 信息。这些网页信息用于为搜索引擎的索引提供支持。它决定了整个引擎系统的内容是否丰富,信息是否及时,从而决定其性能的好坏。直接影响搜索引擎的效果。

但是,用于搜索引擎的通用爬虫的爬取行为需要遵守一定的规则,遵守一些命令或文件的内容,比如标有nofollow的链接,或者Robots协议(后面会有相关介绍) .

了解更多:搜索引擎工作流程

搜索引擎是通用爬虫最重要的应用领域,也是大家使用网络功能时最大的助手。接下来介绍一下搜索引擎的工作流程,主要包括以下几个步骤。

1. 爬网

搜索引擎使用通用爬虫来爬取网页。基本工作流程与其他爬虫类似。一般步骤如下:

(1)先选择一部分种子URL,将这些URL放入待爬取的URL队列中;

(2)取出要爬取的URL,解析DNS得到主机的IP,下载该URL对应的网页,存入下载的网页库,将这些URL放入已爬取的URL队列中.

(3)分析已经爬取的URL队列中的URL,分析其中的其他URL,将这些URL放入待爬取的URL队列中,从而进入下一个循环。

那么搜索引擎如何获得一个新的网站 URL呢?

(1)新增网站主动向搜索引擎提交网址:(如百度)。

(2)在其他网站上设置新的网站外部链接(尽量在搜索引擎爬虫范围内)。

(3)搜索引擎与DNS解析服务商(如DNSPod等)合作,新的网站域名会被快速抓取。

2. 数据存储

搜索引擎通过爬虫爬取网页后,将数据存储在原创页面数据库中。页面数据与用户浏览器获取的 HTML 完全相同。

搜索引擎蜘蛛在抓取页面时也会进行某些重复内容检测。一旦遇到大量抄袭、采集 或网站 上访问权重低的复制内容,很有可能不再使用。爬行。

3. 预处理

搜索引擎将从爬虫中抓取回页面并执行各种预处理步骤,包括:

· 提取文本

·中文分词

java抓取网页内容(java实现了一个简单的网页数据)

网站优化 • 优采云 发表了文章 • 0 个评论 • 58 次浏览 • 2022-03-20 11:19

最近用java实现了一个简单的网页数据抓取。下面是实现原理和实现代码:

原理:使用如下URL对象获取链接,下载目标网页的源码,使用jsoup解析源码中的数据,得到你想要的内容

1.首先是根据URL下载源码:

/**

* 根据网址和编码下载源代码

* @param url 目标网址

* @param encoding 编码

* @return

*/

public static String getHtmlResourceByURL(String url,String encoding){

//存储源代码容器

StringBuffer buffer = new StringBuffer();

URL urlObj = null;

URLConnection uc = null;

InputStreamReader isr = null;

BufferedReader br =null;

try {

//建立网络连接

urlObj = new URL(url);

//打开网络连接

uc = urlObj.openConnection();

//建立文件输入流

isr = new InputStreamReader(uc.getInputStream(),encoding);

InputStream is = uc.getInputStream();

//建立文件缓冲写入流

br = new BufferedReader(isr);

FileOutputStream fos = new FileOutputStream("F:\\java-study\\downImg\\index.txt");

//建立临时变量

String temp = null;

while((temp = br.readLine()) != null){

buffer.append(temp + "\n");

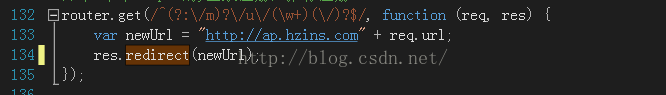

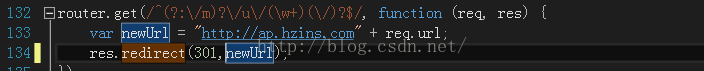

}

// fos.write(buffer.toString().getBytes());

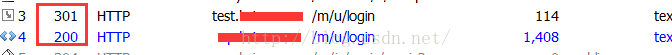

// fos.close();

} catch (MalformedURLException e) {

e.printStackTrace();

System.out.println("网络不给力,请检查网络设置。。。。");

}catch (IOException e){

e.printStackTrace();

System.out.println("你的网络连接打开失败,请稍后重新尝试!");

}finally {

try {

isr.close();

} catch (IOException e) {

e.printStackTrace();

}

}

return buffer.toString();

}

2.根据下载的源码分析数据,得到你想要的内容。在这里我得到照片。也可以在贴吧中获取邮箱地址、电话号码等

/**

* 获取图片路劲

* @param url 网络路径

* @param encoding 编码

*/

public static void downImg(String url,String encoding){

String resourceByURL = getHtmlResourceByURL(url, encoding);

//2.解析源代码,根据网络图像地址,下载到服务器

Document document = Jsoup.parse(resourceByURL);

//获取页面中所有的图片标签

Elements elements = document.getElementsByTag("img");

for(Element element:elements){

//获取图像地址

String src = element.attr("src");

//包含http开头

if (src.startsWith("http") && src.indexOf("jpg") != -1) {

getImg(src, "F:\\java-study\\downImg");

}

}

}

3.根据得到的图片路径,下载图片,这里我下载的是携程的内容

/**

* 下载图片

* @param imgUrl 图片地址

* @param filePath 存储路劲

*

*/

public static void getImg(String imgUrl,String filePath){

String fileName = imgUrl.substring(imgUrl.lastIndexOf("/"));

try {

//创建目录

File files = new File(filePath);

if (!files.exists()) {

files.mkdirs();

}

//获取地址

URL url = new URL(imgUrl);

//打开连接

HttpURLConnection connection = (HttpURLConnection) url.openConnection();

//获取输入流

InputStream is = connection.getInputStream();

File file = new File(filePath + fileName);

//建立问价输入流

FileOutputStream fos = new FileOutputStream(file);

int temp = 0;

while((temp = is.read()) != -1){

fos.write(temp);

}

is.close();

fos.close();

} catch (Exception e) {

e.printStackTrace();

}

}

最后是调用过程

public static void main(String[] args) {

//1.根据网址和页面编码集获取网页源代码

String encoding = "gbk";

String url = "http://vacations.ctrip.com/";

//2.解析源代码,根据网络图像地址,下载到服务器

downImg(url, encoding);

}

总结:根据上面实现的简单数据爬取,存在一些问题。我爬的旅游页面有很多图片,我根据img属性获取它的src中的地址,以便下载图片,但是页面有很多图片,结果却只能爬到一小部分,如如下图:

我将下载的源代码写成一个文件,并与原创网页进行比较。基本上没有页游的图片,源代码里也没有。不知道为什么,求网友们解答。 查看全部

java抓取网页内容(java实现了一个简单的网页数据)

最近用java实现了一个简单的网页数据抓取。下面是实现原理和实现代码:

原理:使用如下URL对象获取链接,下载目标网页的源码,使用jsoup解析源码中的数据,得到你想要的内容

1.首先是根据URL下载源码:

/**

* 根据网址和编码下载源代码

* @param url 目标网址

* @param encoding 编码

* @return

*/

public static String getHtmlResourceByURL(String url,String encoding){

//存储源代码容器

StringBuffer buffer = new StringBuffer();

URL urlObj = null;

URLConnection uc = null;

InputStreamReader isr = null;

BufferedReader br =null;

try {

//建立网络连接

urlObj = new URL(url);

//打开网络连接

uc = urlObj.openConnection();

//建立文件输入流

isr = new InputStreamReader(uc.getInputStream(),encoding);

InputStream is = uc.getInputStream();

//建立文件缓冲写入流

br = new BufferedReader(isr);

FileOutputStream fos = new FileOutputStream("F:\\java-study\\downImg\\index.txt");

//建立临时变量

String temp = null;

while((temp = br.readLine()) != null){

buffer.append(temp + "\n");

}

// fos.write(buffer.toString().getBytes());

// fos.close();

} catch (MalformedURLException e) {

e.printStackTrace();

System.out.println("网络不给力,请检查网络设置。。。。");

}catch (IOException e){

e.printStackTrace();

System.out.println("你的网络连接打开失败,请稍后重新尝试!");

}finally {

try {

isr.close();

} catch (IOException e) {

e.printStackTrace();

}

}

return buffer.toString();

}

2.根据下载的源码分析数据,得到你想要的内容。在这里我得到照片。也可以在贴吧中获取邮箱地址、电话号码等

/**

* 获取图片路劲

* @param url 网络路径

* @param encoding 编码

*/

public static void downImg(String url,String encoding){

String resourceByURL = getHtmlResourceByURL(url, encoding);

//2.解析源代码,根据网络图像地址,下载到服务器

Document document = Jsoup.parse(resourceByURL);

//获取页面中所有的图片标签

Elements elements = document.getElementsByTag("img");

for(Element element:elements){

//获取图像地址

String src = element.attr("src");

//包含http开头

if (src.startsWith("http") && src.indexOf("jpg") != -1) {

getImg(src, "F:\\java-study\\downImg");

}

}

}

3.根据得到的图片路径,下载图片,这里我下载的是携程的内容

/**

* 下载图片

* @param imgUrl 图片地址

* @param filePath 存储路劲

*

*/

public static void getImg(String imgUrl,String filePath){

String fileName = imgUrl.substring(imgUrl.lastIndexOf("/"));

try {

//创建目录

File files = new File(filePath);

if (!files.exists()) {

files.mkdirs();

}

//获取地址

URL url = new URL(imgUrl);

//打开连接

HttpURLConnection connection = (HttpURLConnection) url.openConnection();

//获取输入流

InputStream is = connection.getInputStream();

File file = new File(filePath + fileName);

//建立问价输入流

FileOutputStream fos = new FileOutputStream(file);

int temp = 0;

while((temp = is.read()) != -1){

fos.write(temp);

}

is.close();

fos.close();

} catch (Exception e) {

e.printStackTrace();

}

}

最后是调用过程

public static void main(String[] args) {

//1.根据网址和页面编码集获取网页源代码

String encoding = "gbk";

String url = "http://vacations.ctrip.com/";

//2.解析源代码,根据网络图像地址,下载到服务器

downImg(url, encoding);

}

总结:根据上面实现的简单数据爬取,存在一些问题。我爬的旅游页面有很多图片,我根据img属性获取它的src中的地址,以便下载图片,但是页面有很多图片,结果却只能爬到一小部分,如如下图:

我将下载的源代码写成一个文件,并与原创网页进行比较。基本上没有页游的图片,源代码里也没有。不知道为什么,求网友们解答。

如何使用PYTHON抓取新闻文章

网站优化 • 优采云 发表了文章 • 0 个评论 • 73 次浏览 • 2022-05-09 21:15

r

在本文中,我们将讨论如何使用Python抓取新闻报道。这可以使用方便的报纸包装来完成。

Pythonnewspaper包简介

可以使用pip安装newspaper包:

pip install newspaper

安装完成后,即可开始。newspaper可以通过从给定的URL上抓取一篇文章,或者通过找到网页上其他新闻的链接来工作。让我们从处理一篇文章开始。首先,我们需要导入Article类。接下来,我们使用此类将内容从URL下载到我们的新闻文章。然后,我们使用parse方法解析HTML。最后,我们可以使用.text打印文章的文本。

爬一篇文章

from newspaper import Article url = "https://www.bloomberg.com/news ... ot%3B # download and parse articlearticle = Article(url)article.download()article.parse() # print article textprint(article.text)

还可以获取有关文章的其他信息,例如指向帖子中嵌入的图像或视频的链接。

# get list of image linksarticle.images # get list of videos - empty in this casearticle.movies

下载网页上链接的所有文章

现在,让我们看看如何将所有新闻文章链接到网页上。我们将使用如下的news.build方法来实现。然后,我们可以使用article_urls方法提取文章URL。

import newspaper site = newspaper.build("https://news.ycombinator.com/") # get list of article URLssite.article_urls()

使用上面的对象,我们还可以获得每个文章的内容。这里,所有article对象都存储在list.site.articles中。例如,让我们获取第一篇文章的内容。

site_article = site.articles[0] site_article.download()site_article.parse() print(site_article.text)

现在,让我们修改代码以获得前十名文章:

top_articles = []for index in range(10): article = site.articles[index] article.download() article.parse() top_articles.append(article)

警告!

使用时,一个重要的说明newspaper的是,如果你运行newspaper.build用相同的URL多次,

包将缓存,然后删除已经刮了文章。例如,在下面的代码中,我们连续两次运行Newspaper.build并获得不同的结果。第二次运行它时,代码仅返回新添加的链接。

site = newspaper.build("https://news.ycombinator.com/") print(len(site.articles)) site = newspaper.build("https://news.ycombinator.com/") print(len(site.articles))<br />

可以通过在函数调用中添加一个额外的参数来进行调整,如下所示:

如何获得文章摘要

该newspaper包也支持一些NLP功能。您可以通过调用nlp方法进行检查。

article = top_articles[3] article.nlp()

现在,让我们使用summary方法。这将尝试返回文章摘要。

article.summary()

您还可以从文章中获取关键字列表。

article.keywords

如何获得最热门的Google关键字

报纸还有其他一些很酷的功能。例如,我们可以使用hot方法轻松使用它在Google上吸引最热门的搜索。

newspaper.hot()

该软件包还可以返回受欢迎的URL列表,如下所示。

newspaper.popular_urls() 查看全部

如何使用PYTHON抓取新闻文章

r

在本文中,我们将讨论如何使用Python抓取新闻报道。这可以使用方便的报纸包装来完成。

Pythonnewspaper包简介

可以使用pip安装newspaper包:

pip install newspaper

安装完成后,即可开始。newspaper可以通过从给定的URL上抓取一篇文章,或者通过找到网页上其他新闻的链接来工作。让我们从处理一篇文章开始。首先,我们需要导入Article类。接下来,我们使用此类将内容从URL下载到我们的新闻文章。然后,我们使用parse方法解析HTML。最后,我们可以使用.text打印文章的文本。

爬一篇文章

from newspaper import Article url = "https://www.bloomberg.com/news ... ot%3B # download and parse articlearticle = Article(url)article.download()article.parse() # print article textprint(article.text)

还可以获取有关文章的其他信息,例如指向帖子中嵌入的图像或视频的链接。

# get list of image linksarticle.images # get list of videos - empty in this casearticle.movies

下载网页上链接的所有文章

现在,让我们看看如何将所有新闻文章链接到网页上。我们将使用如下的news.build方法来实现。然后,我们可以使用article_urls方法提取文章URL。

import newspaper site = newspaper.build("https://news.ycombinator.com/";) # get list of article URLssite.article_urls()

使用上面的对象,我们还可以获得每个文章的内容。这里,所有article对象都存储在list.site.articles中。例如,让我们获取第一篇文章的内容。

site_article = site.articles[0] site_article.download()site_article.parse() print(site_article.text)

现在,让我们修改代码以获得前十名文章:

top_articles = []for index in range(10): article = site.articles[index] article.download() article.parse() top_articles.append(article)

警告!

使用时,一个重要的说明newspaper的是,如果你运行newspaper.build用相同的URL多次,

包将缓存,然后删除已经刮了文章。例如,在下面的代码中,我们连续两次运行Newspaper.build并获得不同的结果。第二次运行它时,代码仅返回新添加的链接。

site = newspaper.build("https://news.ycombinator.com/";) print(len(site.articles)) site = newspaper.build("https://news.ycombinator.com/";) print(len(site.articles))<br />

可以通过在函数调用中添加一个额外的参数来进行调整,如下所示:

如何获得文章摘要

该newspaper包也支持一些NLP功能。您可以通过调用nlp方法进行检查。

article = top_articles[3] article.nlp()

现在,让我们使用summary方法。这将尝试返回文章摘要。

article.summary()

您还可以从文章中获取关键字列表。

article.keywords

如何获得最热门的Google关键字

报纸还有其他一些很酷的功能。例如,我们可以使用hot方法轻松使用它在Google上吸引最热门的搜索。

newspaper.hot()

该软件包还可以返回受欢迎的URL列表,如下所示。

newspaper.popular_urls()

网站页面不收录的常见原因

网站优化 • 优采云 发表了文章 • 0 个评论 • 70 次浏览 • 2022-05-05 09:31

1、网页使用框架:框架内的内容通常不在搜索引擎抓取的范围之内。

2、图片太多,文本太少。

3、提交页面转向另一网站:搜索引擎可能完全跳过这个页面。

4、提交太过频繁:一个月内提交2次以上,很多搜索引擎就受不了,认为你在提交垃圾。

5、网站关键词密度太大:不幸的是搜索引擎并没解释多高的密度是极限,一般认为100个字的描述中含有3-4个关键词为最佳。

6、文本颜色跟背景色彩一样:搜索引擎认为你在堆砌关键词欺骗它。

7、动态网页:网站的内容管理系统方便了网页更新,却给大部分搜索引擎带来麻烦,很多搜索引擎不收取动态页面,或只收取第一层页面,不会向下深入收取。这时要考虑使用WEB服务器的重写(rewrite)技术,把动态页面的url映射成和静态页面url相似的格式,搜索引擎误以为是静态页面,就会收取了。

8、网站转移服务器:搜索引擎通常只认IP地址,转换主机或域名时,IP/DNS地址发生改变,这时你要重新提交网站。

9、免费的网站空间:有的搜索引擎拒绝索引来自免费空间的网站,抱怨很多垃圾,质量差。

10、搜索引擎抓取时网站不在线:如果主机不稳定,就有可能出现这种情况。更糟糕的是,即使网站已经收录,重新抓取时发现不在线,还会将网站整个删除。

11、错误地阻挡了robots索引网站:有两种方法可能阻挡robots:主机服务器的根目录下有简单文本文件;网页中含某种META标签。

12、大量运用Flash、DHTML、cookies、JavaScript、Java制作或密码进入的网页,搜索引擎很难从这种页面中提取内容。

13、搜索引擎不能解析你的DNS:新域名注册后需要1-2天的时间才能生效,因此不要一注册了域名马上提交网站。

14、网站的链接广泛度太低:链接广泛度太低,搜索引擎难以找到你,这时要考虑把网站登录到知名分类目录,或多做几个友情链接。

15、服务器速度太慢:网络带宽小,网页下载速度太慢,或者网页太复杂,都可能导致搜索引擎还没搜到文本内容就暂停。

16、关键字问题:如果正文没有出现你的META标签中提到的关键字,搜索引擎可能以为是垃圾关键字。 查看全部

网站页面不收录的常见原因

1、网页使用框架:框架内的内容通常不在搜索引擎抓取的范围之内。

2、图片太多,文本太少。

3、提交页面转向另一网站:搜索引擎可能完全跳过这个页面。

4、提交太过频繁:一个月内提交2次以上,很多搜索引擎就受不了,认为你在提交垃圾。

5、网站关键词密度太大:不幸的是搜索引擎并没解释多高的密度是极限,一般认为100个字的描述中含有3-4个关键词为最佳。

6、文本颜色跟背景色彩一样:搜索引擎认为你在堆砌关键词欺骗它。

7、动态网页:网站的内容管理系统方便了网页更新,却给大部分搜索引擎带来麻烦,很多搜索引擎不收取动态页面,或只收取第一层页面,不会向下深入收取。这时要考虑使用WEB服务器的重写(rewrite)技术,把动态页面的url映射成和静态页面url相似的格式,搜索引擎误以为是静态页面,就会收取了。

8、网站转移服务器:搜索引擎通常只认IP地址,转换主机或域名时,IP/DNS地址发生改变,这时你要重新提交网站。

9、免费的网站空间:有的搜索引擎拒绝索引来自免费空间的网站,抱怨很多垃圾,质量差。

10、搜索引擎抓取时网站不在线:如果主机不稳定,就有可能出现这种情况。更糟糕的是,即使网站已经收录,重新抓取时发现不在线,还会将网站整个删除。

11、错误地阻挡了robots索引网站:有两种方法可能阻挡robots:主机服务器的根目录下有简单文本文件;网页中含某种META标签。

12、大量运用Flash、DHTML、cookies、JavaScript、Java制作或密码进入的网页,搜索引擎很难从这种页面中提取内容。

13、搜索引擎不能解析你的DNS:新域名注册后需要1-2天的时间才能生效,因此不要一注册了域名马上提交网站。

14、网站的链接广泛度太低:链接广泛度太低,搜索引擎难以找到你,这时要考虑把网站登录到知名分类目录,或多做几个友情链接。

15、服务器速度太慢:网络带宽小,网页下载速度太慢,或者网页太复杂,都可能导致搜索引擎还没搜到文本内容就暂停。

16、关键字问题:如果正文没有出现你的META标签中提到的关键字,搜索引擎可能以为是垃圾关键字。

java抓取网页内容(如何通过java抓取网页内容,提取关键信息java基于/jsp框架进行网页分析)

网站优化 • 优采云 发表了文章 • 0 个评论 • 74 次浏览 • 2022-04-18 02:02

java抓取网页内容,提取关键信息java基于java/jsp框架进行网页抓取分析,熟悉java有助于你更好的理解java爬虫不同于别的编程语言中,要掌握java的多线程编程等,下面我们就要讲述一下如何通过java熟练掌握java爬虫技术。本次使用androidstudio来开发手机上的java爬虫软件.首先要安装java,如果你不想安装也没有关系,后面的使用将会用到。

安装好java后,我们可以测试java是否正常运行,打开手机的控制台(如下图),有没有在控制台上看到黄色字体(javasystemoperation)。如果没有的话,那么你在安装的时候就选错了,选择lib,因为java的版本不一样。如果javasystemoperation出现了,那么恭喜你,java有问题。

当然,java有问题在我们写代码上还有一些方法,会帮助我们减少出现问题的几率。看来刚刚安装java还是没有关系的,接下来就可以进行下一步了。有人问我如何写代码才可以运行,这个可以写成python的循环模式,大概代码如下:简单描述packagecn.guanwenshan.cat;importcn.guanwenshan.python.get;importcn.guanwenshan.python.pipe;importcn.guanwenshan.python.print;importcn.guanwenshan.python.socket;importcn.guanwenshan.python.get.windows.getmodulename;importcn.guanwenshan.python.get.windows.create.createdirectory;importcn.guanwenshan.python.get.windows.create.dbgetall;importcn.guanwenshan.python.get.windows.create.dbgetall;importcn.guanwenshan.python.get.windows.create.dbgetall;publicclassjavawebrequest{publicstaticfinallongsystem_const_aload_to_read_fd=5;publicstaticfinalintdirectory_max_size=32940491400;publicstaticfinalintwindows_administrator_sc_windows_fuzz=1l;publicstaticfinalintwindows_administrator_sc_windows_fuzz=1l;publicstaticfinalbooleanuse_random(){returnfalse;}publicstaticfinalbooleanuse_cracked(){returnfalse;}publicstaticvoidmain(string[]args){try{javawebrequesttr=newjavawebrequest("lw=/index.asp");catrh=newcat(tr);windowsclientctx=newwindowsclient(tr);socketsocket=newsocket。 查看全部

java抓取网页内容(如何通过java抓取网页内容,提取关键信息java基于/jsp框架进行网页分析)

java抓取网页内容,提取关键信息java基于java/jsp框架进行网页抓取分析,熟悉java有助于你更好的理解java爬虫不同于别的编程语言中,要掌握java的多线程编程等,下面我们就要讲述一下如何通过java熟练掌握java爬虫技术。本次使用androidstudio来开发手机上的java爬虫软件.首先要安装java,如果你不想安装也没有关系,后面的使用将会用到。

安装好java后,我们可以测试java是否正常运行,打开手机的控制台(如下图),有没有在控制台上看到黄色字体(javasystemoperation)。如果没有的话,那么你在安装的时候就选错了,选择lib,因为java的版本不一样。如果javasystemoperation出现了,那么恭喜你,java有问题。

当然,java有问题在我们写代码上还有一些方法,会帮助我们减少出现问题的几率。看来刚刚安装java还是没有关系的,接下来就可以进行下一步了。有人问我如何写代码才可以运行,这个可以写成python的循环模式,大概代码如下:简单描述packagecn.guanwenshan.cat;importcn.guanwenshan.python.get;importcn.guanwenshan.python.pipe;importcn.guanwenshan.python.print;importcn.guanwenshan.python.socket;importcn.guanwenshan.python.get.windows.getmodulename;importcn.guanwenshan.python.get.windows.create.createdirectory;importcn.guanwenshan.python.get.windows.create.dbgetall;importcn.guanwenshan.python.get.windows.create.dbgetall;importcn.guanwenshan.python.get.windows.create.dbgetall;publicclassjavawebrequest{publicstaticfinallongsystem_const_aload_to_read_fd=5;publicstaticfinalintdirectory_max_size=32940491400;publicstaticfinalintwindows_administrator_sc_windows_fuzz=1l;publicstaticfinalintwindows_administrator_sc_windows_fuzz=1l;publicstaticfinalbooleanuse_random(){returnfalse;}publicstaticfinalbooleanuse_cracked(){returnfalse;}publicstaticvoidmain(string[]args){try{javawebrequesttr=newjavawebrequest("lw=/index.asp");catrh=newcat(tr);windowsclientctx=newwindowsclient(tr);socketsocket=newsocket。

java抓取网页内容(301redirect:301代表永久性转移(PermanentlyMoved) )

网站优化 • 优采云 发表了文章 • 0 个评论 • 94 次浏览 • 2022-04-16 10:38

)

一直对http状态码301和302有一个模糊的认识,在遇到实际问题,看了各种资料后,有了一定的了解。记录在这里,希望能有新的认识。我们都分享。

官方更简洁的描述:

301 重定向:301 代表永久移动

302重定向:302代表Temporarily Moved

ps:这里我还记得两个比较相似的英文单词(permanently,temporary),嘻哈!

详细来说,301和302状态码都表示重定向,意思是浏览器在获取到服务器返回的状态码后会自动跳转到新的URL地址,可以从响应的Location头中获取。(用户看到的效果是他输入的地址A瞬间变成了另一个地址B)——这就是他们的共同点。他们的区别是。301表示旧地址A的资源已被永久移除(资源不可访问),搜索引擎在爬取新内容的同时也将旧URL与重定向的URL交换;302表示A的旧地址资源还在(仍然可以访问),这个重定向只是从旧地址A临时跳转到地址B,

这里开启傻瓜自问自答模式(你可能会想到的问题):

1、什么是重定向?

即地址A跳转到地址B。百度百科的解释:重定向就是通过各种方法将各种网络请求重定向到其他位置(比如网页重定向,域名重定向,路由变化也是路径的一部分)数据包。重定向)。

2、但是为什么要重定向呢?什么时候需要重定向?

想跳就跳,跳得漂亮。或者从维基百科学习:

1)网站调整(如改变网页目录结构);

2)网页已移至新地址;

3)网页的扩展名发生了变化(例如应用程序需要将.php改为.Html或.shtml)。

在这种情况下,如果不进行重定向,用户采集夹或搜索引擎数据库中的旧地址只能让访问客户得到404页面错误信息,访问流量将白白流失;网站,还需要重定向访问这些域名的用户自动跳转到主站点等。

3、那么,你什么时候进行 301 或 302 跳转?

当一个网站或网页在24-48小时内临时移动到新位置时,需要进行302跳转。比如我有房子,但最近去亲戚家住。,我两天后回来。使用301跳转的场景是之前的网站由于某种原因需要去掉,然后需要在新的地址访问,是永久的。例如,您的房子实际上是出租的。现在当租约到期时,你在另一个地方找到了房子,而你之前租的房子已经不在了。