excelvba抓取网页数据

excelvba抓取网页数据(VBA基础的人来说不可能解决问题,我也不想把私信变成聊天窗 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 97 次浏览 • 2021-10-04 05:19

)

因为在知乎的一些回答里,总有私信问我怎么用VBA抓网,但是我基本没有回复。因为这个问题太大了,有基础知识的人其实很容易自己在百度或者ExcelHome论坛上找到答案。我不需要说什么。对于没有基础知识的人来说,是不可能三言两语解决问题的。我不想把私信变成聊天窗口。趁着开专栏知乎的机会,来仔细解释一下这个问题。

我对Excel和VBA的了解有限,只能解决我遇到的一些问题,不一定适用于所有场景。以下内容基于对VBA基本用法和HTML语言知识的了解:

一、前期准备

据我所知,VBA 不能操作任何浏览器和网页。我们所能做的就是在IE上执行一些操作,是的,只有IE。不要告诉我电脑上没有IE,所以你可以退出Sub。就像在Python中使用import,在C#中使用一样,VBA也需要引用一些库来操作IE,不过好在它是微软的产品,所以我们可以很方便的使用VBA自带的一些库。

我们需要做的第一件事是在 VBA 中引用 Micorsoft Internet Controls。通过查看这个名称,我们知道它可以帮助我们控制 IE 页面。

二、网页操作

引用 Micorsoft Internet Controls 后,我们可以对页面做任何我们想做的事情,但是我们需要在主页上有一个页面,上帝说我们需要一个页面!

1、打开网页

我们以在百度上搜索“查虎”关键词为例:

With CreateObject("internetexplorer.application")

.Visible = True

.Navigate "https://www.baidu.com/s?wd=扯乎"

'关闭网页

' .Quit

End With

代码很简单,先创建一个IE对象,然后给一些属性赋值。Visible就是可见性,是指网页被操作时是否会看到网页。熟练后可以设置为False,这样不仅让程序在运行时有一种神秘感(而不是),而且速度也快了一点。

但是有一点要记住,这个网页在我们打开后并没有关闭,这意味着程序结束后需要手动关闭它。如果网页不可见,则无法手动关闭。代码中的注释部分用于关闭网页。不用说,导航就是 URL。

我们必须等待网页完全加载,然后才能开始信息抓取。这时候,我们使用:(从这里开始,所有的代码都需要写在With代码块中)

While .ReadyState 4 Or .Busy

DoEvents

Wend

Busy 是网页的繁忙状态,ReadyState 是 HTTP 的五种就绪状态,对应如下:

2、获取信息

我们先抓取页面上的所有内容,稍后过滤掉有用的部分,然后慢慢添加条件到抓取中。

Set dmt = .Document

For i = 0 To dmt.all.Length - 1

Set htMent = dmt.all(i)

With ActiveSheet

.Cells(i + 2, "A") = htMent.tagName

.Cells(i + 2, "B") = TypeName(htMent)

.Cells(i + 2, "C") = htMent.ID

.Cells(i + 2, "D") = htMent.Name

.Cells(i + 2, "E") = htMent.Value

.Cells(i + 2, "F") = htMent.Text

.Cells(i + 2, "G") = htMent.innerText

End With

Next i

这段代码有点类似于JS,需要从IE.Document.all中找出页面上的所有节点。还有其他几种方法:

这些更方便用于在抓取所有页面内容后帮助过滤有效信息。当然 all 最好用,因为 all 也有 all ("IDName") 和 all.IDName 的用法。

上面代码部分返回的属性值都是基本的HTML内容,就不一一解释了。

3、填写信息

爬网神器当然是Python。大多数人使用Excel自动填写页面内容,直接将表格提交到网页,省去了问卷录入等大量工作。抓取页面内容后,填充起来就更容易了。你只需要直接给页面标签的Value属性赋值即可。

但是,除了文本框,可能还有其他没有Value的标签,比如下拉菜单和单选按钮。给这些内容赋值需要一些基本的HTML知识。

'下拉菜单选择

.all("select")(0).Selected = True

'单选按钮选择

.all("radio").Checked = True

'复选按钮选择

.all("checkbox").Checked = True

下拉菜单是一个select标签,每个选项都在一个option标签中,所以要返回一个集合,需要选择一个选项,将对应的Selected属性修改为True。单选按钮和复选按钮都是输入标签。不同的是类型分别是radio和checkbox。要选择一个选项,您需要修改相应的 Checked 属性。

三、数据接口

有时我们可以直接获取一些API。当然,通过API返回数据比打开网页更方便快捷,使用的方法也有些不同。

1、请求接口

比如我得到了一个可以从网上查询到城市免费WIFI的API,我用下面的代码通过Excel界面访问:(虽然是免费的,为了避免麻烦,我还是隐藏了我的AppKey)

Dim http

Set http = CreateObject("Microsoft.XMLHTTP")

http.Open "GET", "http://api.avatardata.cn/Wifi/QueryByCity", False

http.setRequestHeader "CONTENT-TYPE", "application/x-www-form-urlencoded"

http.send "key=[AppKey]&city=北京&page=1"

这时候我们创建的对象不再是IE,而是HTTP对象。这里使用Ajax的Open方法,GET为数据发送方法,第二个参数为接口地址,第三个参数指定请求方法是否异步。如果这个API有账号和密码,就写在第四个和第五个参数中。

setRequestHeader是向接口发送一个HTTP协议头文件,最后发送的内容就是接口参数。当然,这个QueryString也可以直接写在URL中,发送一个空字符串即可。

2、接口返回

接口返回和获取的方式很简单:

If http.Status = 200 Then Range("A1").Value = http.responseText 查看全部

excelvba抓取网页数据(VBA基础的人来说不可能解决问题,我也不想把私信变成聊天窗

)

因为在知乎的一些回答里,总有私信问我怎么用VBA抓网,但是我基本没有回复。因为这个问题太大了,有基础知识的人其实很容易自己在百度或者ExcelHome论坛上找到答案。我不需要说什么。对于没有基础知识的人来说,是不可能三言两语解决问题的。我不想把私信变成聊天窗口。趁着开专栏知乎的机会,来仔细解释一下这个问题。

我对Excel和VBA的了解有限,只能解决我遇到的一些问题,不一定适用于所有场景。以下内容基于对VBA基本用法和HTML语言知识的了解:

一、前期准备

据我所知,VBA 不能操作任何浏览器和网页。我们所能做的就是在IE上执行一些操作,是的,只有IE。不要告诉我电脑上没有IE,所以你可以退出Sub。就像在Python中使用import,在C#中使用一样,VBA也需要引用一些库来操作IE,不过好在它是微软的产品,所以我们可以很方便的使用VBA自带的一些库。

我们需要做的第一件事是在 VBA 中引用 Micorsoft Internet Controls。通过查看这个名称,我们知道它可以帮助我们控制 IE 页面。

二、网页操作

引用 Micorsoft Internet Controls 后,我们可以对页面做任何我们想做的事情,但是我们需要在主页上有一个页面,上帝说我们需要一个页面!

1、打开网页

我们以在百度上搜索“查虎”关键词为例:

With CreateObject("internetexplorer.application")

.Visible = True

.Navigate "https://www.baidu.com/s?wd=扯乎"

'关闭网页

' .Quit

End With

代码很简单,先创建一个IE对象,然后给一些属性赋值。Visible就是可见性,是指网页被操作时是否会看到网页。熟练后可以设置为False,这样不仅让程序在运行时有一种神秘感(而不是),而且速度也快了一点。

但是有一点要记住,这个网页在我们打开后并没有关闭,这意味着程序结束后需要手动关闭它。如果网页不可见,则无法手动关闭。代码中的注释部分用于关闭网页。不用说,导航就是 URL。

我们必须等待网页完全加载,然后才能开始信息抓取。这时候,我们使用:(从这里开始,所有的代码都需要写在With代码块中)

While .ReadyState 4 Or .Busy

DoEvents

Wend

Busy 是网页的繁忙状态,ReadyState 是 HTTP 的五种就绪状态,对应如下:

2、获取信息

我们先抓取页面上的所有内容,稍后过滤掉有用的部分,然后慢慢添加条件到抓取中。

Set dmt = .Document

For i = 0 To dmt.all.Length - 1

Set htMent = dmt.all(i)

With ActiveSheet

.Cells(i + 2, "A") = htMent.tagName

.Cells(i + 2, "B") = TypeName(htMent)

.Cells(i + 2, "C") = htMent.ID

.Cells(i + 2, "D") = htMent.Name

.Cells(i + 2, "E") = htMent.Value

.Cells(i + 2, "F") = htMent.Text

.Cells(i + 2, "G") = htMent.innerText

End With

Next i

这段代码有点类似于JS,需要从IE.Document.all中找出页面上的所有节点。还有其他几种方法:

这些更方便用于在抓取所有页面内容后帮助过滤有效信息。当然 all 最好用,因为 all 也有 all ("IDName") 和 all.IDName 的用法。

上面代码部分返回的属性值都是基本的HTML内容,就不一一解释了。

3、填写信息

爬网神器当然是Python。大多数人使用Excel自动填写页面内容,直接将表格提交到网页,省去了问卷录入等大量工作。抓取页面内容后,填充起来就更容易了。你只需要直接给页面标签的Value属性赋值即可。

但是,除了文本框,可能还有其他没有Value的标签,比如下拉菜单和单选按钮。给这些内容赋值需要一些基本的HTML知识。

'下拉菜单选择

.all("select")(0).Selected = True

'单选按钮选择

.all("radio").Checked = True

'复选按钮选择

.all("checkbox").Checked = True

下拉菜单是一个select标签,每个选项都在一个option标签中,所以要返回一个集合,需要选择一个选项,将对应的Selected属性修改为True。单选按钮和复选按钮都是输入标签。不同的是类型分别是radio和checkbox。要选择一个选项,您需要修改相应的 Checked 属性。

三、数据接口

有时我们可以直接获取一些API。当然,通过API返回数据比打开网页更方便快捷,使用的方法也有些不同。

1、请求接口

比如我得到了一个可以从网上查询到城市免费WIFI的API,我用下面的代码通过Excel界面访问:(虽然是免费的,为了避免麻烦,我还是隐藏了我的AppKey)

Dim http

Set http = CreateObject("Microsoft.XMLHTTP")

http.Open "GET", "http://api.avatardata.cn/Wifi/QueryByCity", False

http.setRequestHeader "CONTENT-TYPE", "application/x-www-form-urlencoded"

http.send "key=[AppKey]&city=北京&page=1"

这时候我们创建的对象不再是IE,而是HTTP对象。这里使用Ajax的Open方法,GET为数据发送方法,第二个参数为接口地址,第三个参数指定请求方法是否异步。如果这个API有账号和密码,就写在第四个和第五个参数中。

setRequestHeader是向接口发送一个HTTP协议头文件,最后发送的内容就是接口参数。当然,这个QueryString也可以直接写在URL中,发送一个空字符串即可。

2、接口返回

接口返回和获取的方式很简单:

If http.Status = 200 Then Range("A1").Value = http.responseText

excelvba抓取网页数据(Excel教程Excel函数Excel表格制作Excel2010Excel实用技巧Excel视频教程)

网站优化 • 优采云 发表了文章 • 0 个评论 • 99 次浏览 • 2021-10-04 05:15

在做这个项目时,我遇到了将表格数据存储在Excel网页中的问题。我将相关代码分享给你,希望对你有所帮助

出口:

<p>

function AutomateExcel()

{

//下面的这句代码要求浏览器是IE并且需要在Internet选项中设置选项,设置的步骤在最下面

var oXL = new ActiveXObject("Excel.Application"); //创建应该对象

var oWB = oXL.Workbooks.Add();//新建一个Excel工作簿

var oSheet = oWB.ActiveSheet;//指定要写入内容的工作表为活动工作表

var table = document.all.data;//指定要写入的数据源的id

var hang = table.rows.length;//取数据源行数

var lie = table.rows(0).cells.length;//取数据源列数

// Add table headers going cell by cell.

for (i=0;i 查看全部

excelvba抓取网页数据(Excel教程Excel函数Excel表格制作Excel2010Excel实用技巧Excel视频教程)

在做这个项目时,我遇到了将表格数据存储在Excel网页中的问题。我将相关代码分享给你,希望对你有所帮助

出口:

<p>

function AutomateExcel()

{

//下面的这句代码要求浏览器是IE并且需要在Internet选项中设置选项,设置的步骤在最下面

var oXL = new ActiveXObject("Excel.Application"); //创建应该对象

var oWB = oXL.Workbooks.Add();//新建一个Excel工作簿

var oSheet = oWB.ActiveSheet;//指定要写入内容的工作表为活动工作表

var table = document.all.data;//指定要写入的数据源的id

var hang = table.rows.length;//取数据源行数

var lie = table.rows(0).cells.length;//取数据源列数

// Add table headers going cell by cell.

for (i=0;i

excelvba抓取网页数据(vba网页元素代码抓取小工具【支持win10+】用IE提取网页资料)

网站优化 • 优采云 发表了文章 • 0 个评论 • 98 次浏览 • 2021-09-29 06:28

vba网页元素代码抓取小工具【支持win10+】

<p>使用IE提取网页信息的好处是:所见即所得,一般可以得到网页上能看到的信息。这个工具功能不多,主要是方便提取网页显示信息所在元素的代码。我希望我能帮到你一点点。网页爬虫widget.rar (22.91 KB, 下载: 3601) 如何使用这个工具:1、在B1中输入网址,可以是打开的网页也可以是2、A2和B2未打开的内容,不要改,第二行其他单元格可以自己输入元素的属性名称,其中,innertext单元格有一个下拉选项< @3、 并点击“开始”“分析”分析网页元素。< @4、A 列是每个元素的对象代码。5、 在innertext列中找到要提取的内容后,选中该行,点击“生成excel”。表格可以提取标签形式或下载 IMG 标签图像。6、 在新生成的excel中,点击“执行代码”按钮,看看是否可以生成需要的数据。如果生成的数据与分析的数据不匹配,原因可能是:1、网页未完全加载,对应标签的数据尚未加载,代码自动提取后续标签数据。可能的解决方法:添加do...loop time delay。2、 网页为动态网页,标签号不确定。可能的解决方案:如果元素有一个 id 名称,则使用 getelementbyid("id name" ) 获取它,如果没有,则抓取该包并使用 xmlhttp 提取它。 查看全部

excelvba抓取网页数据(vba网页元素代码抓取小工具【支持win10+】用IE提取网页资料)

vba网页元素代码抓取小工具【支持win10+】

<p>使用IE提取网页信息的好处是:所见即所得,一般可以得到网页上能看到的信息。这个工具功能不多,主要是方便提取网页显示信息所在元素的代码。我希望我能帮到你一点点。网页爬虫widget.rar (22.91 KB, 下载: 3601) 如何使用这个工具:1、在B1中输入网址,可以是打开的网页也可以是2、A2和B2未打开的内容,不要改,第二行其他单元格可以自己输入元素的属性名称,其中,innertext单元格有一个下拉选项< @3、 并点击“开始”“分析”分析网页元素。< @4、A 列是每个元素的对象代码。5、 在innertext列中找到要提取的内容后,选中该行,点击“生成excel”。表格可以提取标签形式或下载 IMG 标签图像。6、 在新生成的excel中,点击“执行代码”按钮,看看是否可以生成需要的数据。如果生成的数据与分析的数据不匹配,原因可能是:1、网页未完全加载,对应标签的数据尚未加载,代码自动提取后续标签数据。可能的解决方法:添加do...loop time delay。2、 网页为动态网页,标签号不确定。可能的解决方案:如果元素有一个 id 名称,则使用 getelementbyid("id name" ) 获取它,如果没有,则抓取该包并使用 xmlhttp 提取它。

excelvba抓取网页数据(百度中搜索关键字:网络爬虫写入当前Excel工作表 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 120 次浏览 • 2021-09-24 06:08

)

在百度中搜索关键词“网络爬虫”,将查询结果前5页的数据写入当前Excel工作表中。示例代码如下。

Sub WebQueryBaiduPN()

Dim strURL As String

Dim objXMLHTTP As Object

Dim objDOM As Object

Dim objTitle As Object

Dim intPageNum As Integer

Dim k As Integer

Set objXMLHTTP = CreateObject("MSXML2.XMLHTTP")

Set objDOM = CreateObject("htmlfile")

Cells.ClearContents

Range("a1:c1") = Array("序号", "标题", "链接")

k = 1

For intPageNum = 0 To 50 Step 10

strURL = "https://www.baidu.com/s?"

strURL = strURL & "wd=网络爬虫"

strURL = strURL & "&pn=" & intPageNum

With objXMLHTTP

.Open "GET", strURL, False

.setRequestHeader "If-Modified-Since", "0"

.send

objDOM.body.innerHTML = .responseText

End With

For Each objTitle In objDOM.getElementsByTagName("h3")

k = k + 1

Cells(k, 1) = k - 1

With objTitle.getElementsByTagName("a")(0)

Cells(k, 2) = .innerText

Cells(k, 3) = .href

End With

Next objTitle

Next intPageNum

Set objXMLHTTP = Nothing

Set objDOM = Nothing

Set objTitle = Nothing

End Sub

第16行代码指定获取百度查询结果的页数。通过手动翻百度网页页面,观察Fiddler软件请求框中【WebForms】界面参数的变化,可以发现参数pn代表查询结果的页码。该参数每增加10,网页每增加10更新一次。

代码第17-22行使用MSXML2.XMLHTTP对象发送请求数据,并将获取到的响应信息写入HTML DOM对象的Body标签中。

第 19 行代码指定了请求头域 If-Modified-Since。由于XSXML2.XMLHTTP对象会优先从Excel或IE缓存中读取数据,因此在刷新互联网浏览器数据但未删除缓存时,无法获取网页的最新数据。

If-Modified-Since 是标准的 HTTP 请求标头。发送HTTP请求时,会将浏览器缓存页面的最后修改时间发送给服务器,服务器会将此时间与实际文件的最后修改时间进行比较。

如果时间相同,服务器返回HTTP状态码304而不是文件内容。客户端收到信息后,将本地缓存文件加载到浏览器中。此时,MSXML2.XMLHTTP 对象实际上读取了本地缓存的数据。

相反,如果时间不一致,服务器返回 HTTP 状态码 200 和新文件内容。客户端收到信息后,丢弃旧文件,缓存新文件,加载到浏览器中。此时,MSXML2.XMLHTTP 对象读取服务器发送的新数据。

第23-30行遍历HTML DOM对象的h3标签,是百度网页的三级标题。

第26行至第29行代码分别获取标签下标签为a的第一个子节点的文本内容和链接URL。

运行过程的部分结果如下。

查看全部

excelvba抓取网页数据(百度中搜索关键字:网络爬虫写入当前Excel工作表

)

在百度中搜索关键词“网络爬虫”,将查询结果前5页的数据写入当前Excel工作表中。示例代码如下。

Sub WebQueryBaiduPN()

Dim strURL As String

Dim objXMLHTTP As Object

Dim objDOM As Object

Dim objTitle As Object

Dim intPageNum As Integer

Dim k As Integer

Set objXMLHTTP = CreateObject("MSXML2.XMLHTTP")

Set objDOM = CreateObject("htmlfile")

Cells.ClearContents

Range("a1:c1") = Array("序号", "标题", "链接")

k = 1

For intPageNum = 0 To 50 Step 10

strURL = "https://www.baidu.com/s?"

strURL = strURL & "wd=网络爬虫"

strURL = strURL & "&pn=" & intPageNum

With objXMLHTTP

.Open "GET", strURL, False

.setRequestHeader "If-Modified-Since", "0"

.send

objDOM.body.innerHTML = .responseText

End With

For Each objTitle In objDOM.getElementsByTagName("h3")

k = k + 1

Cells(k, 1) = k - 1

With objTitle.getElementsByTagName("a")(0)

Cells(k, 2) = .innerText

Cells(k, 3) = .href

End With

Next objTitle

Next intPageNum

Set objXMLHTTP = Nothing

Set objDOM = Nothing

Set objTitle = Nothing

End Sub

第16行代码指定获取百度查询结果的页数。通过手动翻百度网页页面,观察Fiddler软件请求框中【WebForms】界面参数的变化,可以发现参数pn代表查询结果的页码。该参数每增加10,网页每增加10更新一次。

代码第17-22行使用MSXML2.XMLHTTP对象发送请求数据,并将获取到的响应信息写入HTML DOM对象的Body标签中。

第 19 行代码指定了请求头域 If-Modified-Since。由于XSXML2.XMLHTTP对象会优先从Excel或IE缓存中读取数据,因此在刷新互联网浏览器数据但未删除缓存时,无法获取网页的最新数据。

If-Modified-Since 是标准的 HTTP 请求标头。发送HTTP请求时,会将浏览器缓存页面的最后修改时间发送给服务器,服务器会将此时间与实际文件的最后修改时间进行比较。

如果时间相同,服务器返回HTTP状态码304而不是文件内容。客户端收到信息后,将本地缓存文件加载到浏览器中。此时,MSXML2.XMLHTTP 对象实际上读取了本地缓存的数据。

相反,如果时间不一致,服务器返回 HTTP 状态码 200 和新文件内容。客户端收到信息后,丢弃旧文件,缓存新文件,加载到浏览器中。此时,MSXML2.XMLHTTP 对象读取服务器发送的新数据。

第23-30行遍历HTML DOM对象的h3标签,是百度网页的三级标题。

第26行至第29行代码分别获取标签下标签为a的第一个子节点的文本内容和链接URL。

运行过程的部分结果如下。

excelvba抓取网页数据(轻松用Excel获取网页数据的一些初步的爬虫方法(图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 626 次浏览 • 2021-09-24 06:06

我们通常使用 Excel,并且经常处理本地数据。您知道如何在 Excel 中进行排序、筛选、条件格式、数据透视表、图表等……但您可能不了解 Excel 是如何获取网页数据的!

网络爬虫?!您可能认为您必须编写代码来实现这一点。其实除了代码,Excel还有一些现成的功能,让你不用代码也能获取网页的数据!

下面的方法中,前三个不需要写代码,最后一个需要代码,但是我已经写好了,可以用了,所以你也可以学习轻松使用Excel来获取一些网页爬虫的初步页面数据方法!

函数方法

从 Excel 2013 版本开始,引入了一些 Web 功能。下面两个函数可以配合使用,帮助我们把网页的数据获取到Excel中。

FILTERXML(xml, xpath),从 XML 数据中返回指定的数据。网页上的许多数据都以 XML 的形式存在。该函数用于提取 XML 中的指定信息。

WEBSERVICE(url),返回网页中的数据,可以理解为这个函数可以得到一堆XML字符串数据。

例如下面的公式使用有道的网站得到翻译结果:

=FILTERXML(WEBSERVICE(";i="&B2&"&doctype=xml&version"),"//翻译")

如果你把上面的公式复制到Excel,你只需要在B2单元格输入你要翻译的内容,公式就会把翻译好的结果返回给你!

是不是感觉超级方便!对于外部数据的轻量级连接,这个函数方法是相当方便的。

除了翻译,使用此功能还可以协助您进行股票交易!我在工作,不方便使用手机或看财经网页,但我想关注实时股价。怎么破解?

把下面的公式复制到B1单元格,然后在A1单元格输入你关注的股票代码,B1可以显示实时股价,想刷新就按F9~

=VALUE(TRIM(MID(SUBSTITUTE(WEBSERVICE(""&A1&"&time="&TEXT(NOW(),"hhmmss")),",",REPT("",99)),2* 99,111)))

当你全神贯注地看着Excel工作(chao)为(gu)时,即使老板突然经过,你也能从容应对!不要让你的老板知道这个技能!

但是你也需要注意使用这个公式。首先,您必须确保您的计算机可以正常连接到互联网。另外,如果有道调整了网页代码或更改了URL入口,则上述公式也将失效。你需要再研究一下逻辑。写公式~

旧版网页查询功能

Excel2016之前一直有获取网页数据的功能,在Excel2016推出PQ后隐藏了,但是还是可以手动调出!

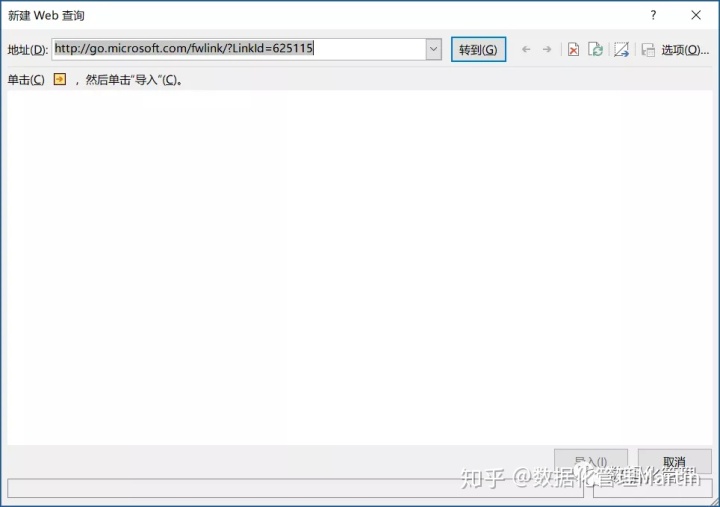

手动调用的方法可以在“选项”中的“数据”中设置其显示,也可以直接按快捷键Alt+D+D+W(注意:在同时,只需按顺序按即可!),然后会弹出如下界面:

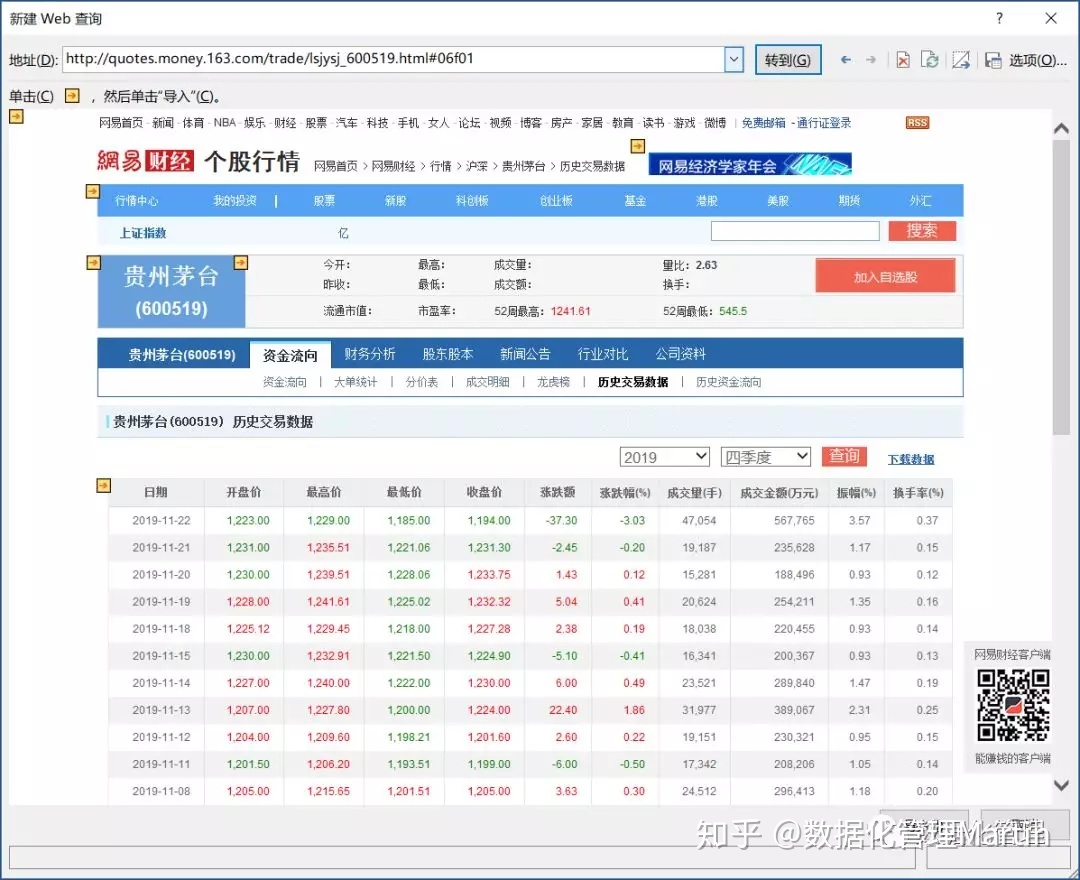

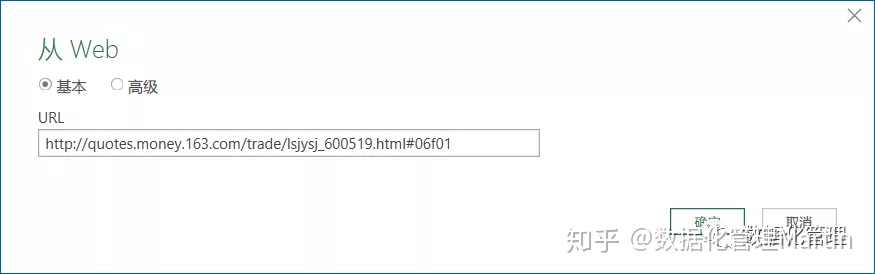

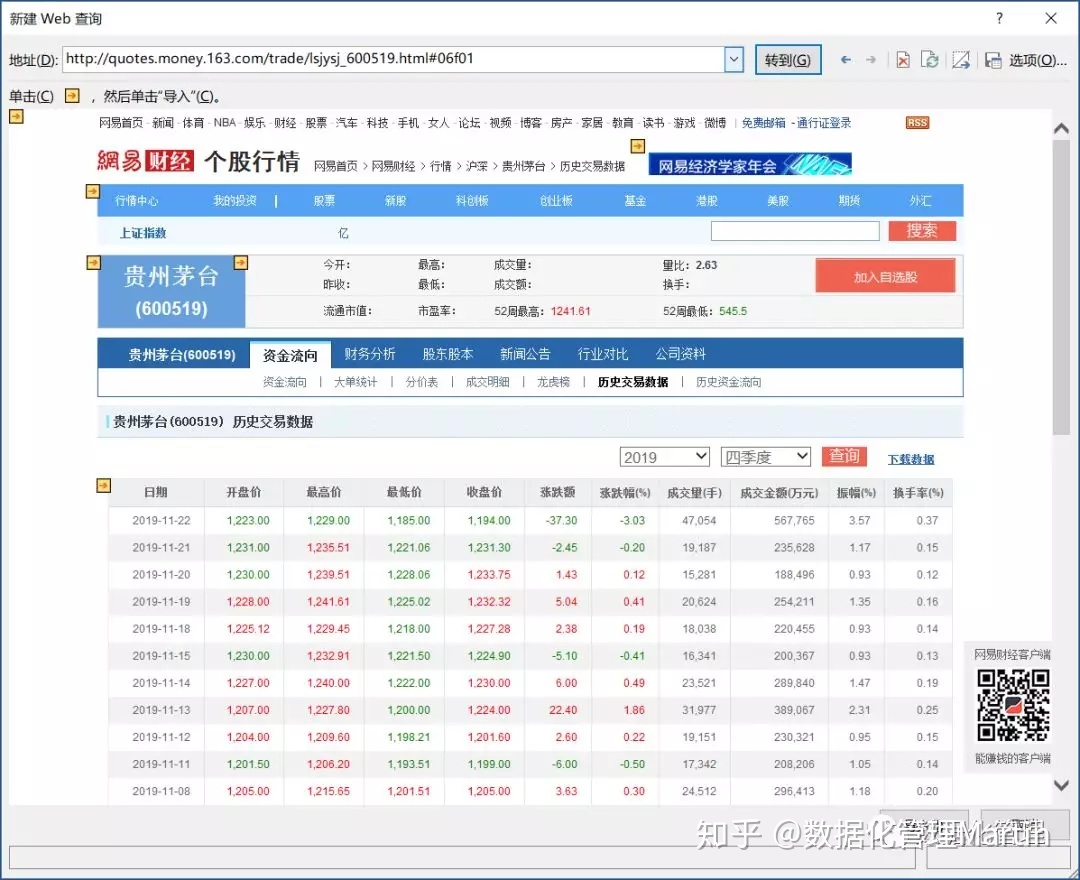

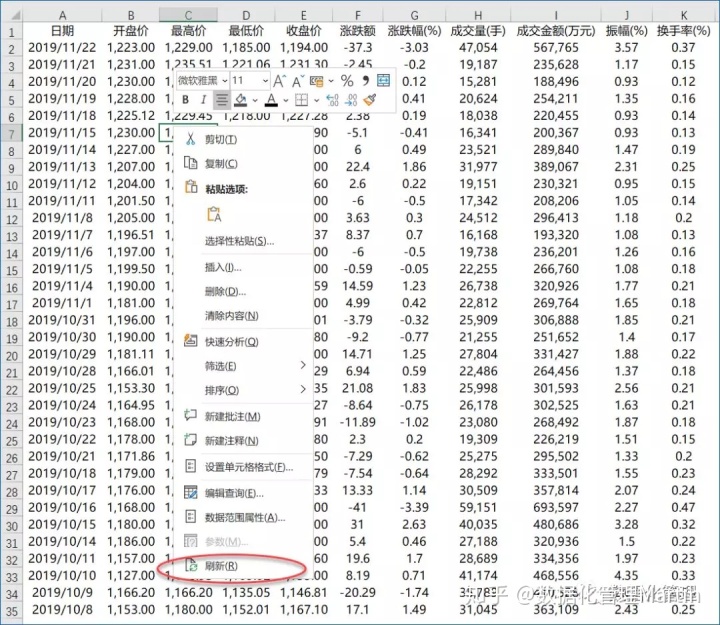

然后我们只需要输入网页地址即可。图中地址为#06f01。

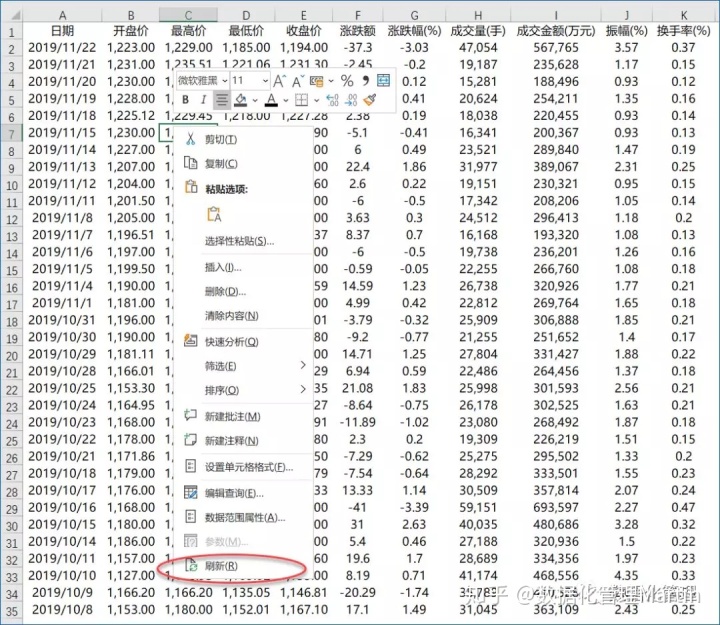

这个功能可以帮助我们识别网页中的表格,然后我们只需要选中表格(点击黄色箭头选择),点击右下角的导入,然后将数据导入到Excel中即可!

而且还可以刷新这张表,同时支持手动刷新和自动刷新,非常方便~

这种方法的问题是不是所有的网页都能获取到数据,因为你可能无法获取到真实的网址,所以你应该尽量找到最深入的地址。你有爬取的方法,别人有反爬取的方法,所以如果继续获取网页上的数据,需要密切关注网页是否发生了变化~

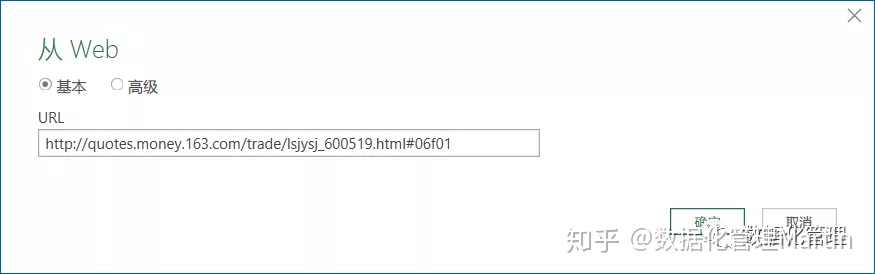

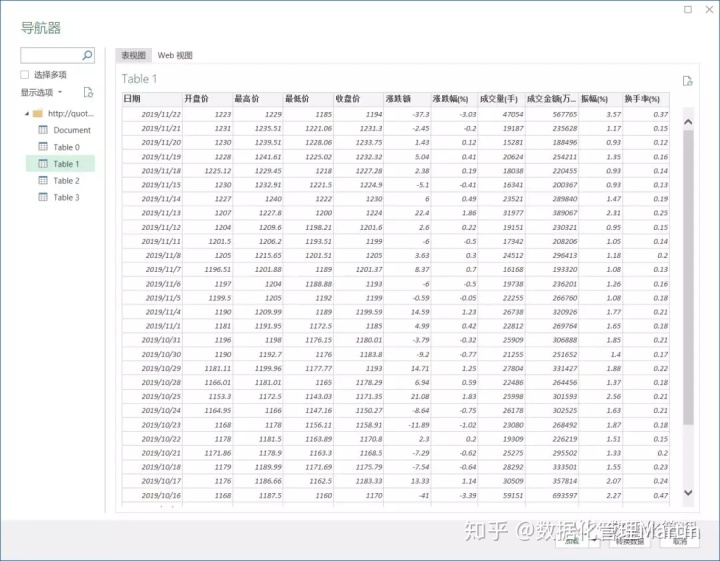

Power Query 获取网页数据

从 Excel 2016 开始,PQ 已经集成到 Excel 中,并计划用它来代替旧版本的数据查询和获取功能,所以使用 PQ 也可以帮助我们获取网页的数据!

由于动画太大无法上传,我将使用截图来说明步骤:

1、 点击上面的“From 网站”,输入网址,点击“OK”

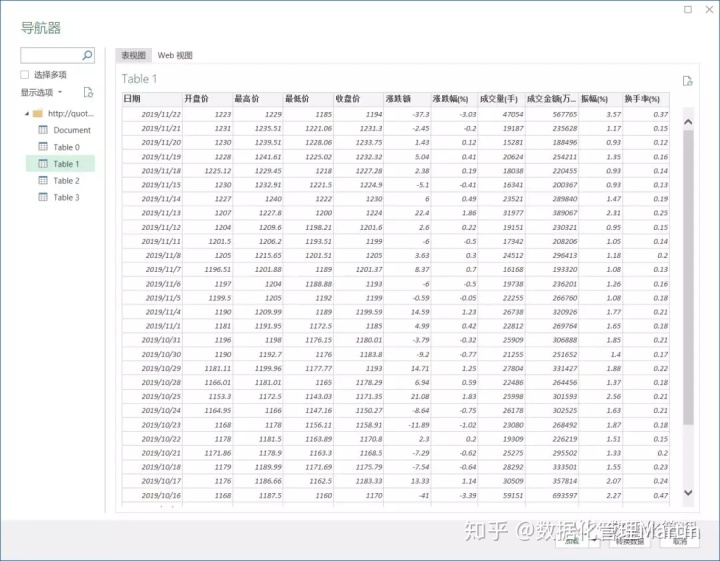

2、 在出现的导航器中,点击Table开头的图标,右边会有这些表格的预览,选择要导入的表格,点击右下角的“Load”角落

3、 然后就可以把表格数据导出到Excel了,还支持手动刷新和自动刷新!

VBA代码方法

其实以上方法都算不上真正的“爬虫”技巧。如果想更灵活地获取数据,就需要使用VBA代码。

使用VBA获取网页数据,当然也可以结合以上三种方式使用,因为写代码意味着可以判断和循环,就像上面的股票收盘价信息一样,通过循环可以得到多个股票数据会更方便!

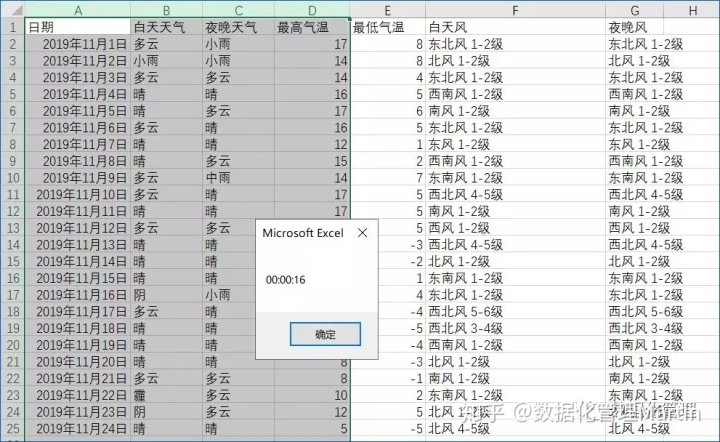

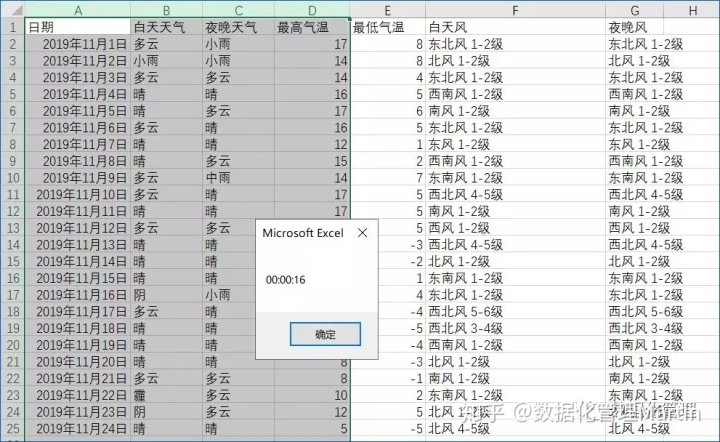

比如用VBA调用第二种方法,结合Excel的基本功能对数据进行排序和提取,就可以实现历史天气数据的获取!下面的方法使用VBA获取天气数据~

对于零售业来说,天气确实是一个非常重要的因素,会影响客流和季节性商品的销售。因此,有必要对历史天气数据进行分析!

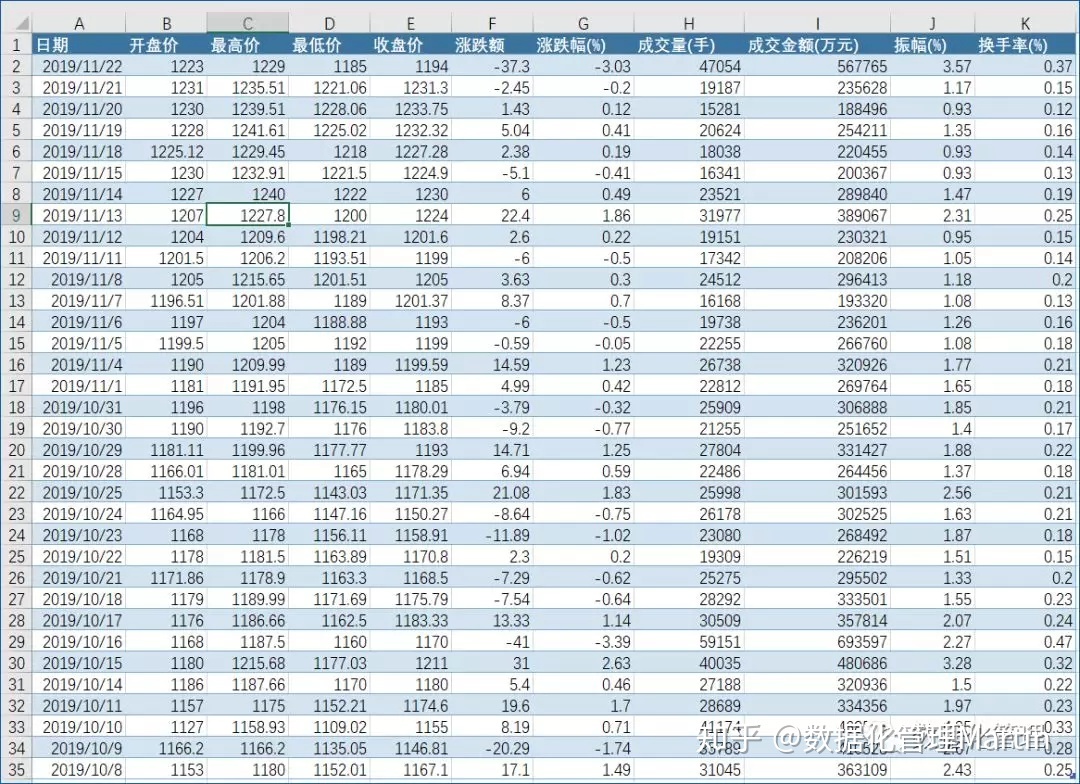

如何批量获取天气数据?以下是获取北京2019年11月历史天气数据的结果:

这需要使用 VBA 代码。以上方法不适合大量获取数据。不会打码?没关系,我已经写好了,也有解释。复制后,稍加修改即可使用。(代码在文末)

如果你还想获取多个城市、多个年份、多个月份的数据,那么你需要考虑更多的情况。可以根据文末提供的代码修改实现。 查看全部

excelvba抓取网页数据(轻松用Excel获取网页数据的一些初步的爬虫方法(图))

我们通常使用 Excel,并且经常处理本地数据。您知道如何在 Excel 中进行排序、筛选、条件格式、数据透视表、图表等……但您可能不了解 Excel 是如何获取网页数据的!

网络爬虫?!您可能认为您必须编写代码来实现这一点。其实除了代码,Excel还有一些现成的功能,让你不用代码也能获取网页的数据!

下面的方法中,前三个不需要写代码,最后一个需要代码,但是我已经写好了,可以用了,所以你也可以学习轻松使用Excel来获取一些网页爬虫的初步页面数据方法!

函数方法

从 Excel 2013 版本开始,引入了一些 Web 功能。下面两个函数可以配合使用,帮助我们把网页的数据获取到Excel中。

FILTERXML(xml, xpath),从 XML 数据中返回指定的数据。网页上的许多数据都以 XML 的形式存在。该函数用于提取 XML 中的指定信息。

WEBSERVICE(url),返回网页中的数据,可以理解为这个函数可以得到一堆XML字符串数据。

例如下面的公式使用有道的网站得到翻译结果:

=FILTERXML(WEBSERVICE(";i="&B2&"&doctype=xml&version"),"//翻译")

如果你把上面的公式复制到Excel,你只需要在B2单元格输入你要翻译的内容,公式就会把翻译好的结果返回给你!

是不是感觉超级方便!对于外部数据的轻量级连接,这个函数方法是相当方便的。

除了翻译,使用此功能还可以协助您进行股票交易!我在工作,不方便使用手机或看财经网页,但我想关注实时股价。怎么破解?

把下面的公式复制到B1单元格,然后在A1单元格输入你关注的股票代码,B1可以显示实时股价,想刷新就按F9~

=VALUE(TRIM(MID(SUBSTITUTE(WEBSERVICE(""&A1&"&time="&TEXT(NOW(),"hhmmss")),",",REPT("",99)),2* 99,111)))

当你全神贯注地看着Excel工作(chao)为(gu)时,即使老板突然经过,你也能从容应对!不要让你的老板知道这个技能!

但是你也需要注意使用这个公式。首先,您必须确保您的计算机可以正常连接到互联网。另外,如果有道调整了网页代码或更改了URL入口,则上述公式也将失效。你需要再研究一下逻辑。写公式~

旧版网页查询功能

Excel2016之前一直有获取网页数据的功能,在Excel2016推出PQ后隐藏了,但是还是可以手动调出!

手动调用的方法可以在“选项”中的“数据”中设置其显示,也可以直接按快捷键Alt+D+D+W(注意:在同时,只需按顺序按即可!),然后会弹出如下界面:

然后我们只需要输入网页地址即可。图中地址为#06f01。

这个功能可以帮助我们识别网页中的表格,然后我们只需要选中表格(点击黄色箭头选择),点击右下角的导入,然后将数据导入到Excel中即可!

而且还可以刷新这张表,同时支持手动刷新和自动刷新,非常方便~

这种方法的问题是不是所有的网页都能获取到数据,因为你可能无法获取到真实的网址,所以你应该尽量找到最深入的地址。你有爬取的方法,别人有反爬取的方法,所以如果继续获取网页上的数据,需要密切关注网页是否发生了变化~

Power Query 获取网页数据

从 Excel 2016 开始,PQ 已经集成到 Excel 中,并计划用它来代替旧版本的数据查询和获取功能,所以使用 PQ 也可以帮助我们获取网页的数据!

由于动画太大无法上传,我将使用截图来说明步骤:

1、 点击上面的“From 网站”,输入网址,点击“OK”

2、 在出现的导航器中,点击Table开头的图标,右边会有这些表格的预览,选择要导入的表格,点击右下角的“Load”角落

3、 然后就可以把表格数据导出到Excel了,还支持手动刷新和自动刷新!

VBA代码方法

其实以上方法都算不上真正的“爬虫”技巧。如果想更灵活地获取数据,就需要使用VBA代码。

使用VBA获取网页数据,当然也可以结合以上三种方式使用,因为写代码意味着可以判断和循环,就像上面的股票收盘价信息一样,通过循环可以得到多个股票数据会更方便!

比如用VBA调用第二种方法,结合Excel的基本功能对数据进行排序和提取,就可以实现历史天气数据的获取!下面的方法使用VBA获取天气数据~

对于零售业来说,天气确实是一个非常重要的因素,会影响客流和季节性商品的销售。因此,有必要对历史天气数据进行分析!

如何批量获取天气数据?以下是获取北京2019年11月历史天气数据的结果:

这需要使用 VBA 代码。以上方法不适合大量获取数据。不会打码?没关系,我已经写好了,也有解释。复制后,稍加修改即可使用。(代码在文末)

如果你还想获取多个城市、多个年份、多个月份的数据,那么你需要考虑更多的情况。可以根据文末提供的代码修改实现。

excelvba抓取网页数据(如何获取百度查询结果——百度抓取结果的个数 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 106 次浏览 • 2021-09-24 06:06

)

当用户通过网络浏览器登录互联网时,他会向网络服务器请求某个网页。服务器收到请求后,会响应,将设置好的页面文件发送到浏览器的显示界面。这是一个完整的网页请求和处理的过程。Netscrape 尝试在代码过程中模拟这种交互过程。

首先,在 Excel 中使用 VBA 来捕获 网站 数据。

其次,无论是使用Python、java还是VBA进行网页抓取,都需要对HTTP协议、HTML(HyperTextMarkup Language)和DOM(文档对象模型)有初步的了解。

此外,还介绍了一个软件 Fiddler。网络爬虫的成功需要准确真实的URL,模拟正确的请求消息,分析服务器响应请求后返回的信息,这些数据可以通过Fiddler软件获取。通过 Fiddler 很容易找到内容所在的 URL。

今天简单介绍一下如何获取百度查询结果——抓取的百度查询结果数量。

1.首先打开Fiddler软件,在浏览器中打开百度网站,搜索关键词“网络爬虫”。

2.在Fiddler软件中搜索“百度为你找到相关结果”,如下图。

3. 点击对话框中的第一个黄色数据,点击右侧Request框中的【Raw】按钮,可以查看发送请求的HTTP报文的详细数据。第一行是请求行,内容如下。

GET https://www.baidu.com/s%3Fwd%3 ... D6639 HTTP/1.1

开头的GET为请求方法字段,结尾的HTTP/1.1为协议版本字段,其余信息为URL字段。由于请求行使用 GET 方法,因此请求数据将附加到 URL。URL和请求数据用“?”分隔,多个参数用“&”连接。

虽然传输数据的参数很多,但并不是所有的参数都是必须的。在Request框中选择【WebForms】选项卡,可以查看多个参数的Name和对应的Value。百度搜索到的关键词“网络爬虫”位于参数wd下,如下图所示。因此,URL 可以简明如下。

网络爬虫

4. 在Request框中点击【Raw】按钮查看响应报文的详细数据,点击框右下角的【在记事本中查看】按钮将相关数据转换为记事本文件格式。在记事本中搜索关键词“百度为你找到了相关结果”,即可查看收录该关键词的相关数据。

示例代码如下。

<p>Sub WebQueryBaidu()

Dim objXMLHTTP As Object

Dim strURL As String

Dim strText As String

Set objXMLHTTP = CreateObject("MSXML2.XMLHTTP")

With objXMLHTTP

strURL = "https://www.baidu.com/s?wd=网络爬虫"

.Open "GET", strURL, False

.send

strText = .responseText

End With

Range("a1") = "百度:excelhome 结果个数为:"

Range("a2") = Split(Split(strText, "百度为您找到相关结果")(1), " 查看全部

excelvba抓取网页数据(如何获取百度查询结果——百度抓取结果的个数

)

当用户通过网络浏览器登录互联网时,他会向网络服务器请求某个网页。服务器收到请求后,会响应,将设置好的页面文件发送到浏览器的显示界面。这是一个完整的网页请求和处理的过程。Netscrape 尝试在代码过程中模拟这种交互过程。

首先,在 Excel 中使用 VBA 来捕获 网站 数据。

其次,无论是使用Python、java还是VBA进行网页抓取,都需要对HTTP协议、HTML(HyperTextMarkup Language)和DOM(文档对象模型)有初步的了解。

此外,还介绍了一个软件 Fiddler。网络爬虫的成功需要准确真实的URL,模拟正确的请求消息,分析服务器响应请求后返回的信息,这些数据可以通过Fiddler软件获取。通过 Fiddler 很容易找到内容所在的 URL。

今天简单介绍一下如何获取百度查询结果——抓取的百度查询结果数量。

1.首先打开Fiddler软件,在浏览器中打开百度网站,搜索关键词“网络爬虫”。

2.在Fiddler软件中搜索“百度为你找到相关结果”,如下图。

3. 点击对话框中的第一个黄色数据,点击右侧Request框中的【Raw】按钮,可以查看发送请求的HTTP报文的详细数据。第一行是请求行,内容如下。

GET https://www.baidu.com/s%3Fwd%3 ... D6639 HTTP/1.1

开头的GET为请求方法字段,结尾的HTTP/1.1为协议版本字段,其余信息为URL字段。由于请求行使用 GET 方法,因此请求数据将附加到 URL。URL和请求数据用“?”分隔,多个参数用“&”连接。

虽然传输数据的参数很多,但并不是所有的参数都是必须的。在Request框中选择【WebForms】选项卡,可以查看多个参数的Name和对应的Value。百度搜索到的关键词“网络爬虫”位于参数wd下,如下图所示。因此,URL 可以简明如下。

网络爬虫

4. 在Request框中点击【Raw】按钮查看响应报文的详细数据,点击框右下角的【在记事本中查看】按钮将相关数据转换为记事本文件格式。在记事本中搜索关键词“百度为你找到了相关结果”,即可查看收录该关键词的相关数据。

示例代码如下。

<p>Sub WebQueryBaidu()

Dim objXMLHTTP As Object

Dim strURL As String

Dim strText As String

Set objXMLHTTP = CreateObject("MSXML2.XMLHTTP")

With objXMLHTTP

strURL = "https://www.baidu.com/s?wd=网络爬虫"

.Open "GET", strURL, False

.send

strText = .responseText

End With

Range("a1") = "百度:excelhome 结果个数为:"

Range("a2") = Split(Split(strText, "百度为您找到相关结果")(1), "

excelvba抓取网页数据( Excelvba如何抓取指定的网页数据到单元格/>1)

网站优化 • 优采云 发表了文章 • 0 个评论 • 298 次浏览 • 2021-09-19 12:09

Excelvba如何抓取指定的网页数据到单元格/>1)

Sub getHTML()<br /><br />Dim http<br />Set http = CreateObject("Msxml2.ServerXMLHTTP")<br />http.Open "GET", "https://zhidao.baidu.com/quest ... ot%3B, False<br />http.send<br />Debug.Print http.Status<br />Debug.Print http.responsetext<br /><br />End Sub

Excel VBA如何将指定的网页数据抓取到单元格“/>

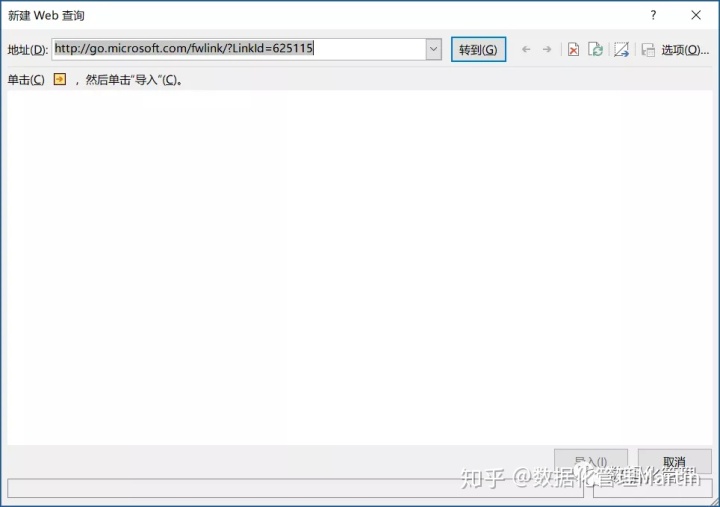

1、打开excel,单击“数据”和“新建web查询”。来吧

2、在互联网上搜索列表,复制网站并单击“go”

3、单击“隐藏图标”,选择此列表,单击“导入”源,然后单击“确定”导入数据

4、如果要查询实时数据,请在粘贴区域右键单击鼠标,然后单击“刷新”完成。下面将显示后台查询、将网页内容复制到表中等

如果这

您必须熟悉Excel中的VBA

您可以在Excel home中询问一些VBA专家

在这里很难见面

看来你对基础有点了解。一点学习,然后结合VBA就可以了

此文章标记:从excel中提取网页元素(1)excel自动提取网页数据(1))@ 查看全部

excelvba抓取网页数据(

Excelvba如何抓取指定的网页数据到单元格/>1)

Sub getHTML()<br /><br />Dim http<br />Set http = CreateObject("Msxml2.ServerXMLHTTP")<br />http.Open "GET", "https://zhidao.baidu.com/quest ... ot%3B, False<br />http.send<br />Debug.Print http.Status<br />Debug.Print http.responsetext<br /><br />End Sub

Excel VBA如何将指定的网页数据抓取到单元格“/>

1、打开excel,单击“数据”和“新建web查询”。来吧

2、在互联网上搜索列表,复制网站并单击“go”

3、单击“隐藏图标”,选择此列表,单击“导入”源,然后单击“确定”导入数据

4、如果要查询实时数据,请在粘贴区域右键单击鼠标,然后单击“刷新”完成。下面将显示后台查询、将网页内容复制到表中等

如果这

您必须熟悉Excel中的VBA

您可以在Excel home中询问一些VBA专家

在这里很难见面

看来你对基础有点了解。一点学习,然后结合VBA就可以了

此文章标记:从excel中提取网页元素(1)excel自动提取网页数据(1))@

excelvba抓取网页数据(专题“利用IE抓取网络数据”的第二节(图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 72 次浏览 • 2021-09-18 23:15

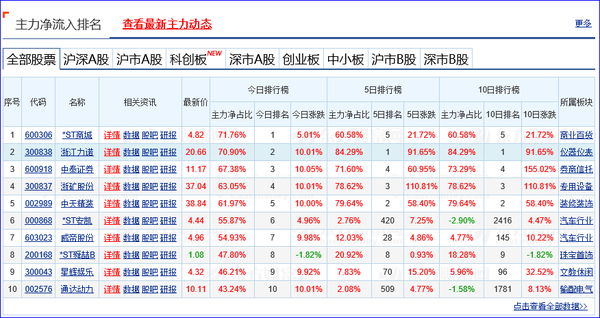

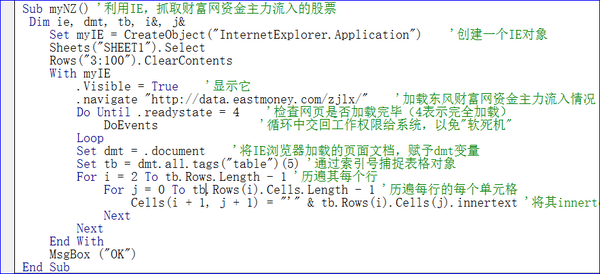

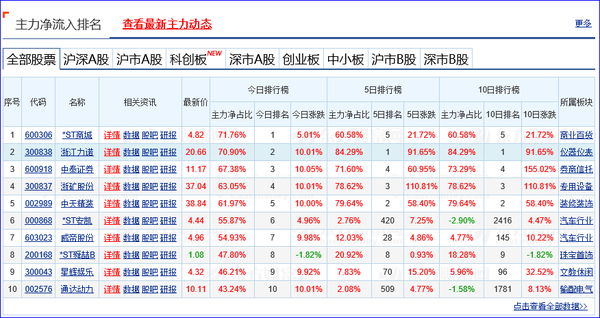

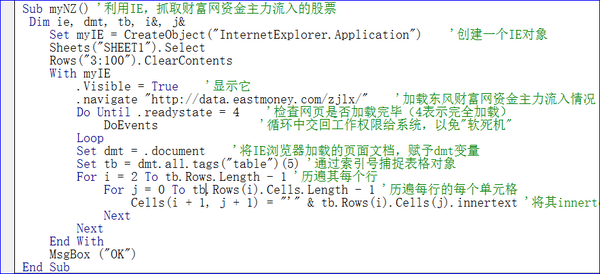

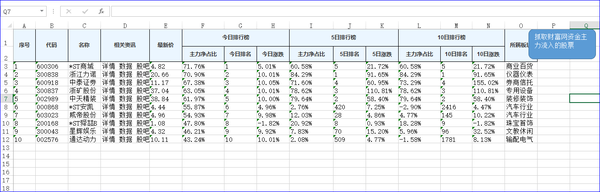

各位好。今天,我们将解释“VBA信息获取和处理”教程“使用IE捕获股票”中第九个主题“通过IE捕获网络数据”的第二部分,这是一个非常有用的知识点。我希望你能掌握它

第二节利用IE捕捉主要资本流入的存量

大家好,让我们从使用IE控件捕获网络数据的任务开始。由于基础知识已经解释了很多,这里的代码解释将更简单。您可以参考我给出的代码注释来理解

实施场景:当我们进行股票分析时,我们最关心的是基金的趋势。是否有大量资本流入是大多数散户投资者投资股票的重要依据。我们以《财富》网站提供的主要资本流入的股票数据作为数据提取的依据。该网站为:/zjlx/

1利用IE获取主要资本流入数据的思路分析

为了捕获数据,让我们首先看看web页面。以下是2020年6月11日网页提供的数据:

我们的任务是将上述数据捕获到excel表格中。为了使用IE进行数据捕获,我们首先需要创建一个IE引用CreateObject(“InternetExplorer.Application”)。然后,ie打开给定的web地址并单击。导航“/zjlx/”已实现。我们从网页上得到该表的序列号为5,然后提取该表中的数据。您可以回顾我以前关于表的知识。从web文档中提取文档对象,使用dmt.all.tags(“表”)(5)查找表,然后使用TB.Rows(I).Cells(J).InnerText输出数据

2使用IE实现主要资本流入数据捕获的代码

为了实现上述想法,我给出了以下代码:

Sub mynz()'使用IE捕获主要资本流入的股票

Dim ie、dmt、tb、i&;、j&

设置MyIE=CreateObject(“internetexplorer.Application”)'创建IE对象

图纸(“图纸1”)。选择

行(“3:100”)。ClearContents

和myIE在一起

.visible=true“显示它

.navigate“/zjlx/”加载东风财富网的主要资金流入

直到.ReadyState=4'检查网页是否已加载(4表示满载)

在“Doevents”循环中将工作权限返回给系统,以避免“软崩溃”

环路

Set DMT=.Document'将IE浏览器加载的页面文档分配给DMT变量

设置TB=dmt.all.tags(“table”)(5)'按索引号捕获表对象

对于I=2到tb.rows.length,通过其每行的长度为-1'

对于J=0到TB.Rows(I).Cells.Length-1'通过每行中的每个单元格

单元格(I+1,j+1)=“””和TB.Rows(I).Cells(j).InnerText”将其InnerText写入单元格

下一个

下一个

以

MsgBox(“OK”)

端接头

代码截图:

代码分析:

1)SetMyIE=CreateObject(“Internet Explorer.Application”)此代码用于创建IE对象或更高版本的绑定。可以使用引用

2)板材(“板材1”)。选择

行(“3:100”)。ClearContents

清除要填充的数据区域

3)和myIE

.visible=true“显示它

.导航“/zjlx/”

以上代码加载ie中的“/zjlx/”网站,即东风财富网的主要资金流入

4)do until.ReadyState=4'检查网页是否已加载(4表示满载)

在“Doevents”循环中将工作权限返回给系统,以避免“软崩溃”

环路

这段代码是让网页加载,以便以后提取网页的数据

5)SetDMT=.Document'将IE浏览器加载的页面文档分配给DMT变量,其中DMT是一个对象变量

6)set TB=DMT.All.Tags(“table”)(5))通过索引号捕获表对象。此处的序列号来自我们对网页的分析。您还可以使用工具分析网页

7)ForI=2到tb.rows.length-1'通过其每一行

对于J=0到TB.Rows(I).Cells.Length-1'通过每行中的每个单元格

单元格(I+1,j+1)=“””和TB.Rows(I).Cells(j).InnerText”将其InnerText写入单元格

下一个

下一个

提取表的数据,其中TB.Rows.Length–1是行数;TB.Rows(I).Cells(J).InnerText是单元格的内容

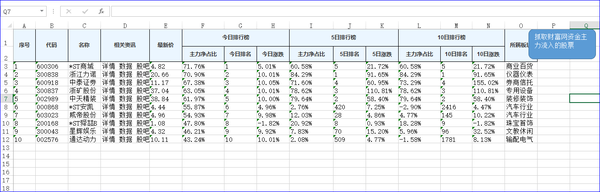

3.应用IE获取主要资本流入数据

我们单击页面上的“运行”按钮以捕获以下数据:

从实施效果来看,完全满足我们的场景需求

回到本节中的知识点:如何从页面文档中提取表数据

有关本节内容,请参阅009工作表.xlsm

构建块编程的思想和内涵:

在我的系列书籍中,我一直强调“积木”的编程思想,这也是学习和使用VBA的主要方法,尤其是对于专业人士而言。其主要内涵是:

1.不要自己输入所有代码。你要做的是将构建块放在正确的位置,然后更正代码。一定要复制它,从构建块库复制它,然后更正代码,以便利用你的时间进行有效思考

2.建立你自己的“积木库”。在学习过程中,把你认为有用的代码放在一起,积累更多,你可以在任何时候使用它。积木库中的信息越多,你在制作程序时的想法就越多

VBA的应用定义

VBA是利用office实现个人小型办公自动化的有效手段(工具)。这是我对VBA应用的定义。在取代office的新办公软件到来之前,谁能在数据处理方面取得最好成绩,谁就是王者。其中,VBA是最强大的技能

我记得20年前我第一次学习VBA时,材料很少。我只能看源代码,自己思考。这真的很难。20年后,为了不让我的朋友学习VBA重复我以前的经验,我在多年实践VBA的基础上开设了六门VBA特别课程经验:

第一套:VBA代码解决方案是解释VBA中的各种知识点。本教程共有147节课,涵盖了绝大多数VBA知识点,这是初学者所必需的

第二套:VBA数据库解决方案数据库是数据处理的专业工具,本教程详细介绍了用ADO连接accdb和excel的方法和示例操作,适合中级人员使用

第三套:VBA数组和字典解决方案数组和字典是VBA的精髓。字典是提高VBA代码水平的有效手段,值得深入学习。它是高级和中级人员代码的一种手段

第四套:VBA代码解决方案视频是针对初学者的视频讲解,可以快速入门,更快掌握这项技能。这套教程是第一套教程的视频讲解,更容易听元音

第五套:VBA中的课堂解读与运用。这是一门解释课堂虚无和肉体程度的高级课程。虽然课堂运用较少,但认真学习可以促进自身VBA理论的完善。对这套课程的理解主要是对f读者与一种佛教哲学

第六套教程:VBA信息获取与处理,这是一门高级课程,涵盖范围更广,对中高级人员更实用。该课程有20个主题,包括:跨应用程序信息获取、随机信息的利用、电子邮件发送、VBA Internet数据捕获、VBA delay操作、剪贴板应用程序、拆分功能扩展、工作表信息与其他应用程序的交互、FSO对象的使用、工作表和文件夹信息获取、图形信息获取和自定义工作表信息功能等

根据以上信息,您可以按照1的顺序逐步学习→ 3.→ 2.→ 6.→ 5或4→ 3.→ 2.→ 6.→ 5.本教程提供了说明和大量构建块。如果需要,您可以微信:nz9668

学习VBA是一个过程,也需要经历一种无聊的感觉

正如太白的诗所说:鸟儿高飞,寂寞的云朵独自消遣。你们不会厌倦彼此的相见,只有静亭山。学习的过程也是培养心灵的过程,培养一颗平静的心。在密码的世界里,当你的心灵平静时,你的身体自然会很好。当你平静时,你会很好没错。如果你心中没有那么多邪恶的知识和观点,你就不会有那么多妄想。对别人有益是自利。这些教程也是帮助你启航和帮助我的。我上面的教程是我的经验的传递

“水对万物都有好处,没有争议"学习也是一样。你知道你需要什么。不要蜷缩在一个你认为是天堂的小世界里。不要欺骗自己和他人,直到你年老。努力提高自己,用充满活力的心和精神把握现在。这是进步。事情越有意义,困难就越多。愿意做决定n智慧决定成败。无论你遇到什么,它都是一道风景。忽视争端,轻视得失。不管茶是满的还是小的,浓的还是淡的,它都有自己的味道值得品尝。去f 查看全部

excelvba抓取网页数据(专题“利用IE抓取网络数据”的第二节(图))

各位好。今天,我们将解释“VBA信息获取和处理”教程“使用IE捕获股票”中第九个主题“通过IE捕获网络数据”的第二部分,这是一个非常有用的知识点。我希望你能掌握它

第二节利用IE捕捉主要资本流入的存量

大家好,让我们从使用IE控件捕获网络数据的任务开始。由于基础知识已经解释了很多,这里的代码解释将更简单。您可以参考我给出的代码注释来理解

实施场景:当我们进行股票分析时,我们最关心的是基金的趋势。是否有大量资本流入是大多数散户投资者投资股票的重要依据。我们以《财富》网站提供的主要资本流入的股票数据作为数据提取的依据。该网站为:/zjlx/

1利用IE获取主要资本流入数据的思路分析

为了捕获数据,让我们首先看看web页面。以下是2020年6月11日网页提供的数据:

我们的任务是将上述数据捕获到excel表格中。为了使用IE进行数据捕获,我们首先需要创建一个IE引用CreateObject(“InternetExplorer.Application”)。然后,ie打开给定的web地址并单击。导航“/zjlx/”已实现。我们从网页上得到该表的序列号为5,然后提取该表中的数据。您可以回顾我以前关于表的知识。从web文档中提取文档对象,使用dmt.all.tags(“表”)(5)查找表,然后使用TB.Rows(I).Cells(J).InnerText输出数据

2使用IE实现主要资本流入数据捕获的代码

为了实现上述想法,我给出了以下代码:

Sub mynz()'使用IE捕获主要资本流入的股票

Dim ie、dmt、tb、i&;、j&

设置MyIE=CreateObject(“internetexplorer.Application”)'创建IE对象

图纸(“图纸1”)。选择

行(“3:100”)。ClearContents

和myIE在一起

.visible=true“显示它

.navigate“/zjlx/”加载东风财富网的主要资金流入

直到.ReadyState=4'检查网页是否已加载(4表示满载)

在“Doevents”循环中将工作权限返回给系统,以避免“软崩溃”

环路

Set DMT=.Document'将IE浏览器加载的页面文档分配给DMT变量

设置TB=dmt.all.tags(“table”)(5)'按索引号捕获表对象

对于I=2到tb.rows.length,通过其每行的长度为-1'

对于J=0到TB.Rows(I).Cells.Length-1'通过每行中的每个单元格

单元格(I+1,j+1)=“””和TB.Rows(I).Cells(j).InnerText”将其InnerText写入单元格

下一个

下一个

以

MsgBox(“OK”)

端接头

代码截图:

代码分析:

1)SetMyIE=CreateObject(“Internet Explorer.Application”)此代码用于创建IE对象或更高版本的绑定。可以使用引用

2)板材(“板材1”)。选择

行(“3:100”)。ClearContents

清除要填充的数据区域

3)和myIE

.visible=true“显示它

.导航“/zjlx/”

以上代码加载ie中的“/zjlx/”网站,即东风财富网的主要资金流入

4)do until.ReadyState=4'检查网页是否已加载(4表示满载)

在“Doevents”循环中将工作权限返回给系统,以避免“软崩溃”

环路

这段代码是让网页加载,以便以后提取网页的数据

5)SetDMT=.Document'将IE浏览器加载的页面文档分配给DMT变量,其中DMT是一个对象变量

6)set TB=DMT.All.Tags(“table”)(5))通过索引号捕获表对象。此处的序列号来自我们对网页的分析。您还可以使用工具分析网页

7)ForI=2到tb.rows.length-1'通过其每一行

对于J=0到TB.Rows(I).Cells.Length-1'通过每行中的每个单元格

单元格(I+1,j+1)=“””和TB.Rows(I).Cells(j).InnerText”将其InnerText写入单元格

下一个

下一个

提取表的数据,其中TB.Rows.Length–1是行数;TB.Rows(I).Cells(J).InnerText是单元格的内容

3.应用IE获取主要资本流入数据

我们单击页面上的“运行”按钮以捕获以下数据:

从实施效果来看,完全满足我们的场景需求

回到本节中的知识点:如何从页面文档中提取表数据

有关本节内容,请参阅009工作表.xlsm

构建块编程的思想和内涵:

在我的系列书籍中,我一直强调“积木”的编程思想,这也是学习和使用VBA的主要方法,尤其是对于专业人士而言。其主要内涵是:

1.不要自己输入所有代码。你要做的是将构建块放在正确的位置,然后更正代码。一定要复制它,从构建块库复制它,然后更正代码,以便利用你的时间进行有效思考

2.建立你自己的“积木库”。在学习过程中,把你认为有用的代码放在一起,积累更多,你可以在任何时候使用它。积木库中的信息越多,你在制作程序时的想法就越多

VBA的应用定义

VBA是利用office实现个人小型办公自动化的有效手段(工具)。这是我对VBA应用的定义。在取代office的新办公软件到来之前,谁能在数据处理方面取得最好成绩,谁就是王者。其中,VBA是最强大的技能

我记得20年前我第一次学习VBA时,材料很少。我只能看源代码,自己思考。这真的很难。20年后,为了不让我的朋友学习VBA重复我以前的经验,我在多年实践VBA的基础上开设了六门VBA特别课程经验:

第一套:VBA代码解决方案是解释VBA中的各种知识点。本教程共有147节课,涵盖了绝大多数VBA知识点,这是初学者所必需的

第二套:VBA数据库解决方案数据库是数据处理的专业工具,本教程详细介绍了用ADO连接accdb和excel的方法和示例操作,适合中级人员使用

第三套:VBA数组和字典解决方案数组和字典是VBA的精髓。字典是提高VBA代码水平的有效手段,值得深入学习。它是高级和中级人员代码的一种手段

第四套:VBA代码解决方案视频是针对初学者的视频讲解,可以快速入门,更快掌握这项技能。这套教程是第一套教程的视频讲解,更容易听元音

第五套:VBA中的课堂解读与运用。这是一门解释课堂虚无和肉体程度的高级课程。虽然课堂运用较少,但认真学习可以促进自身VBA理论的完善。对这套课程的理解主要是对f读者与一种佛教哲学

第六套教程:VBA信息获取与处理,这是一门高级课程,涵盖范围更广,对中高级人员更实用。该课程有20个主题,包括:跨应用程序信息获取、随机信息的利用、电子邮件发送、VBA Internet数据捕获、VBA delay操作、剪贴板应用程序、拆分功能扩展、工作表信息与其他应用程序的交互、FSO对象的使用、工作表和文件夹信息获取、图形信息获取和自定义工作表信息功能等

根据以上信息,您可以按照1的顺序逐步学习→ 3.→ 2.→ 6.→ 5或4→ 3.→ 2.→ 6.→ 5.本教程提供了说明和大量构建块。如果需要,您可以微信:nz9668

学习VBA是一个过程,也需要经历一种无聊的感觉

正如太白的诗所说:鸟儿高飞,寂寞的云朵独自消遣。你们不会厌倦彼此的相见,只有静亭山。学习的过程也是培养心灵的过程,培养一颗平静的心。在密码的世界里,当你的心灵平静时,你的身体自然会很好。当你平静时,你会很好没错。如果你心中没有那么多邪恶的知识和观点,你就不会有那么多妄想。对别人有益是自利。这些教程也是帮助你启航和帮助我的。我上面的教程是我的经验的传递

“水对万物都有好处,没有争议"学习也是一样。你知道你需要什么。不要蜷缩在一个你认为是天堂的小世界里。不要欺骗自己和他人,直到你年老。努力提高自己,用充满活力的心和精神把握现在。这是进步。事情越有意义,困难就越多。愿意做决定n智慧决定成败。无论你遇到什么,它都是一道风景。忽视争端,轻视得失。不管茶是满的还是小的,浓的还是淡的,它都有自己的味道值得品尝。去f

excelvba抓取网页数据(获取网页数据链接、识别汉字编码、转换和处理字符串并得到所需要的简单方法)

网站优化 • 优采云 发表了文章 • 0 个评论 • 478 次浏览 • 2021-09-11 13:12

第 1 课总结:

本课通过实例讲解获取网页数据链接、识别汉字编码、转换处理字符串、获取所需数据的简单方法。请课后找一些网站duoduo的测试,练习抓包软件的使用和获取字符串后拆分等功能提取数据的基本技巧。

在实际的网页采集中,我们经常会遇到比例子网站复杂几倍甚至几十倍的网页。一个完整的网页采集程序需要处理以下问题:

1、 如有必要,请登录网站。可能需要验证码(需要拿到图片做OCR识别)

2、找到网站的初始链接,获取cookie或viewstate等隐藏提交信息,准备提交真实数据链接。

3、如有需要可以找网站中文语言的设置方法,可以直接写在链接里,也可以写在提交的参数里,也可以提交专门的语言设置链接。

4、找到网站的数据链路,抓包获取Referer值,解决反盗链

5、处理初始网页,获取后续数据链接提交所需的参数(可能没有,也可能有很多)

6、Process 网站data 链接的提交参数(可能有时间戳),可能是GET或POST。后者还要处理URLEncode编码或者其他形式的编码(如果是UTF-8编码,XMLHTTP会自己处理;WinHttp可以通过参数选择URL编码格式)。

7、Judge 网站返回数据的编码处理成可识别的字符串(可能需要htmlfile对象快速操作html文档中的表格等)

8、处理需要采集数据的字符串,可能需要从中提取页码,可能需要提取下一页的参数,可能需要使用数组提取需要的信息(尤其是网络表单)

9、 循环执行 6~8 直到数据提取结束

其实无论网站多么复杂,获取数据的基础无非是两点:

1、抓包查看链接、Cookie、Referer、Post参数、隐藏提交参数、MD5或RSA加密参数等,然后模拟提交

2、处理编码和提取字符串

只要熟练掌握这两个基本步骤,再加上充足的时间、坚定的信念、耐心和一点点运气,采集网站的工作就迎刃而解!

相信我

附上一些VBA调用JS函数的方法。 查看全部

excelvba抓取网页数据(获取网页数据链接、识别汉字编码、转换和处理字符串并得到所需要的简单方法)

第 1 课总结:

本课通过实例讲解获取网页数据链接、识别汉字编码、转换处理字符串、获取所需数据的简单方法。请课后找一些网站duoduo的测试,练习抓包软件的使用和获取字符串后拆分等功能提取数据的基本技巧。

在实际的网页采集中,我们经常会遇到比例子网站复杂几倍甚至几十倍的网页。一个完整的网页采集程序需要处理以下问题:

1、 如有必要,请登录网站。可能需要验证码(需要拿到图片做OCR识别)

2、找到网站的初始链接,获取cookie或viewstate等隐藏提交信息,准备提交真实数据链接。

3、如有需要可以找网站中文语言的设置方法,可以直接写在链接里,也可以写在提交的参数里,也可以提交专门的语言设置链接。

4、找到网站的数据链路,抓包获取Referer值,解决反盗链

5、处理初始网页,获取后续数据链接提交所需的参数(可能没有,也可能有很多)

6、Process 网站data 链接的提交参数(可能有时间戳),可能是GET或POST。后者还要处理URLEncode编码或者其他形式的编码(如果是UTF-8编码,XMLHTTP会自己处理;WinHttp可以通过参数选择URL编码格式)。

7、Judge 网站返回数据的编码处理成可识别的字符串(可能需要htmlfile对象快速操作html文档中的表格等)

8、处理需要采集数据的字符串,可能需要从中提取页码,可能需要提取下一页的参数,可能需要使用数组提取需要的信息(尤其是网络表单)

9、 循环执行 6~8 直到数据提取结束

其实无论网站多么复杂,获取数据的基础无非是两点:

1、抓包查看链接、Cookie、Referer、Post参数、隐藏提交参数、MD5或RSA加密参数等,然后模拟提交

2、处理编码和提取字符串

只要熟练掌握这两个基本步骤,再加上充足的时间、坚定的信念、耐心和一点点运气,采集网站的工作就迎刃而解!

相信我

附上一些VBA调用JS函数的方法。

excelvba抓取网页数据( 关键词:excelvba股票,vbavba获取股票历史数据,获取)

网站优化 • 优采云 发表了文章 • 0 个评论 • 193 次浏览 • 2021-09-11 02:11

关键词:excelvba股票,vbavba获取股票历史数据,获取)

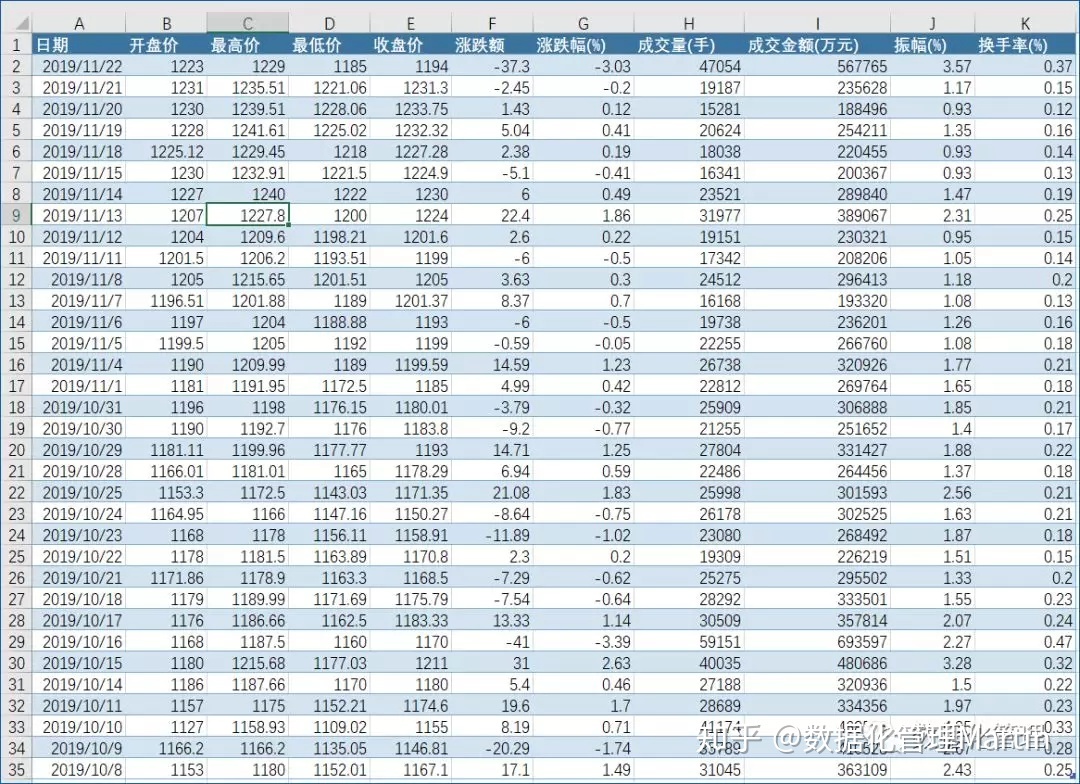

使用EXCEL VBA获取股票历史交易明细等高频数据

关键词:excel vba股票,vba获取历史股票数据,excel vba抓取网站data

这个东西是原创。原理是使用VBA从网页中获取数据,但不需要打开网页。

VBA在后台打开虚拟网页,分析抓取数据,速度相当快。我的网速一般,从一个网页中获取数据只需要大约 1 秒。

本程序可以实现以下功能:

1、导入任何一只股票自上市以来的开盘价、收盘价、最高价、最低价、成交量等数据;

2、 导入任意交易日任意股票的交易明细。包括交易时间、交易价格、交易量、交易金额等,对于一些需要高频数据的同学来说,这个东西很实用。本程序稍作修改,增加一个循环甚至导出所有股票的所有历史交易明细。有需要的同学可以找我。

3、导入新股会议数据,包括公司名称、申请时间、会议时间、当前状态等信息。

一般网页上的数据可以用VBA抓取,应用不错,可以实现大量数据的动态监控。

如果需要获取其他数据,可以私信给我。

这么好的东西不应该沉没,所以有钱就回复下载吧;如果你没有钱,回复我并寄给你。

补充内容(2014-3-22 14:21):

补充几个问题:

1、很多人找我要文件,我尽力了,可惜不能一一发。

2、 有人问我要源码,抱歉不能一一解答,也不好贴在这里。

3、如果你问我如何学习VBA,最好找这本教材有点基础知识。

使用EXCEL VBA获取股票历史交易明细等高频数据。抓取网页数据链接:密码:j33p

转载请注明:数据分析»使用EXCEL VBA获取股票历史交易明细等高频数据 查看全部

excelvba抓取网页数据(

关键词:excelvba股票,vbavba获取股票历史数据,获取)

使用EXCEL VBA获取股票历史交易明细等高频数据

关键词:excel vba股票,vba获取历史股票数据,excel vba抓取网站data

这个东西是原创。原理是使用VBA从网页中获取数据,但不需要打开网页。

VBA在后台打开虚拟网页,分析抓取数据,速度相当快。我的网速一般,从一个网页中获取数据只需要大约 1 秒。

本程序可以实现以下功能:

1、导入任何一只股票自上市以来的开盘价、收盘价、最高价、最低价、成交量等数据;

2、 导入任意交易日任意股票的交易明细。包括交易时间、交易价格、交易量、交易金额等,对于一些需要高频数据的同学来说,这个东西很实用。本程序稍作修改,增加一个循环甚至导出所有股票的所有历史交易明细。有需要的同学可以找我。

3、导入新股会议数据,包括公司名称、申请时间、会议时间、当前状态等信息。

一般网页上的数据可以用VBA抓取,应用不错,可以实现大量数据的动态监控。

如果需要获取其他数据,可以私信给我。

这么好的东西不应该沉没,所以有钱就回复下载吧;如果你没有钱,回复我并寄给你。

补充内容(2014-3-22 14:21):

补充几个问题:

1、很多人找我要文件,我尽力了,可惜不能一一发。

2、 有人问我要源码,抱歉不能一一解答,也不好贴在这里。

3、如果你问我如何学习VBA,最好找这本教材有点基础知识。

使用EXCEL VBA获取股票历史交易明细等高频数据。抓取网页数据链接:密码:j33p

转载请注明:数据分析»使用EXCEL VBA获取股票历史交易明细等高频数据

excelvba抓取网页数据(VBA基础的人来说不可能解决问题,我也不想把私信变成聊天窗 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 97 次浏览 • 2021-10-04 05:19

)

因为在知乎的一些回答里,总有私信问我怎么用VBA抓网,但是我基本没有回复。因为这个问题太大了,有基础知识的人其实很容易自己在百度或者ExcelHome论坛上找到答案。我不需要说什么。对于没有基础知识的人来说,是不可能三言两语解决问题的。我不想把私信变成聊天窗口。趁着开专栏知乎的机会,来仔细解释一下这个问题。

我对Excel和VBA的了解有限,只能解决我遇到的一些问题,不一定适用于所有场景。以下内容基于对VBA基本用法和HTML语言知识的了解:

一、前期准备

据我所知,VBA 不能操作任何浏览器和网页。我们所能做的就是在IE上执行一些操作,是的,只有IE。不要告诉我电脑上没有IE,所以你可以退出Sub。就像在Python中使用import,在C#中使用一样,VBA也需要引用一些库来操作IE,不过好在它是微软的产品,所以我们可以很方便的使用VBA自带的一些库。

我们需要做的第一件事是在 VBA 中引用 Micorsoft Internet Controls。通过查看这个名称,我们知道它可以帮助我们控制 IE 页面。

二、网页操作

引用 Micorsoft Internet Controls 后,我们可以对页面做任何我们想做的事情,但是我们需要在主页上有一个页面,上帝说我们需要一个页面!

1、打开网页

我们以在百度上搜索“查虎”关键词为例:

With CreateObject("internetexplorer.application")

.Visible = True

.Navigate "https://www.baidu.com/s?wd=扯乎"

'关闭网页

' .Quit

End With

代码很简单,先创建一个IE对象,然后给一些属性赋值。Visible就是可见性,是指网页被操作时是否会看到网页。熟练后可以设置为False,这样不仅让程序在运行时有一种神秘感(而不是),而且速度也快了一点。

但是有一点要记住,这个网页在我们打开后并没有关闭,这意味着程序结束后需要手动关闭它。如果网页不可见,则无法手动关闭。代码中的注释部分用于关闭网页。不用说,导航就是 URL。

我们必须等待网页完全加载,然后才能开始信息抓取。这时候,我们使用:(从这里开始,所有的代码都需要写在With代码块中)

While .ReadyState 4 Or .Busy

DoEvents

Wend

Busy 是网页的繁忙状态,ReadyState 是 HTTP 的五种就绪状态,对应如下:

2、获取信息

我们先抓取页面上的所有内容,稍后过滤掉有用的部分,然后慢慢添加条件到抓取中。

Set dmt = .Document

For i = 0 To dmt.all.Length - 1

Set htMent = dmt.all(i)

With ActiveSheet

.Cells(i + 2, "A") = htMent.tagName

.Cells(i + 2, "B") = TypeName(htMent)

.Cells(i + 2, "C") = htMent.ID

.Cells(i + 2, "D") = htMent.Name

.Cells(i + 2, "E") = htMent.Value

.Cells(i + 2, "F") = htMent.Text

.Cells(i + 2, "G") = htMent.innerText

End With

Next i

这段代码有点类似于JS,需要从IE.Document.all中找出页面上的所有节点。还有其他几种方法:

这些更方便用于在抓取所有页面内容后帮助过滤有效信息。当然 all 最好用,因为 all 也有 all ("IDName") 和 all.IDName 的用法。

上面代码部分返回的属性值都是基本的HTML内容,就不一一解释了。

3、填写信息

爬网神器当然是Python。大多数人使用Excel自动填写页面内容,直接将表格提交到网页,省去了问卷录入等大量工作。抓取页面内容后,填充起来就更容易了。你只需要直接给页面标签的Value属性赋值即可。

但是,除了文本框,可能还有其他没有Value的标签,比如下拉菜单和单选按钮。给这些内容赋值需要一些基本的HTML知识。

'下拉菜单选择

.all("select")(0).Selected = True

'单选按钮选择

.all("radio").Checked = True

'复选按钮选择

.all("checkbox").Checked = True

下拉菜单是一个select标签,每个选项都在一个option标签中,所以要返回一个集合,需要选择一个选项,将对应的Selected属性修改为True。单选按钮和复选按钮都是输入标签。不同的是类型分别是radio和checkbox。要选择一个选项,您需要修改相应的 Checked 属性。

三、数据接口

有时我们可以直接获取一些API。当然,通过API返回数据比打开网页更方便快捷,使用的方法也有些不同。

1、请求接口

比如我得到了一个可以从网上查询到城市免费WIFI的API,我用下面的代码通过Excel界面访问:(虽然是免费的,为了避免麻烦,我还是隐藏了我的AppKey)

Dim http

Set http = CreateObject("Microsoft.XMLHTTP")

http.Open "GET", "http://api.avatardata.cn/Wifi/QueryByCity", False

http.setRequestHeader "CONTENT-TYPE", "application/x-www-form-urlencoded"

http.send "key=[AppKey]&city=北京&page=1"

这时候我们创建的对象不再是IE,而是HTTP对象。这里使用Ajax的Open方法,GET为数据发送方法,第二个参数为接口地址,第三个参数指定请求方法是否异步。如果这个API有账号和密码,就写在第四个和第五个参数中。

setRequestHeader是向接口发送一个HTTP协议头文件,最后发送的内容就是接口参数。当然,这个QueryString也可以直接写在URL中,发送一个空字符串即可。

2、接口返回

接口返回和获取的方式很简单:

If http.Status = 200 Then Range("A1").Value = http.responseText 查看全部

excelvba抓取网页数据(VBA基础的人来说不可能解决问题,我也不想把私信变成聊天窗

)

因为在知乎的一些回答里,总有私信问我怎么用VBA抓网,但是我基本没有回复。因为这个问题太大了,有基础知识的人其实很容易自己在百度或者ExcelHome论坛上找到答案。我不需要说什么。对于没有基础知识的人来说,是不可能三言两语解决问题的。我不想把私信变成聊天窗口。趁着开专栏知乎的机会,来仔细解释一下这个问题。

我对Excel和VBA的了解有限,只能解决我遇到的一些问题,不一定适用于所有场景。以下内容基于对VBA基本用法和HTML语言知识的了解:

一、前期准备

据我所知,VBA 不能操作任何浏览器和网页。我们所能做的就是在IE上执行一些操作,是的,只有IE。不要告诉我电脑上没有IE,所以你可以退出Sub。就像在Python中使用import,在C#中使用一样,VBA也需要引用一些库来操作IE,不过好在它是微软的产品,所以我们可以很方便的使用VBA自带的一些库。

我们需要做的第一件事是在 VBA 中引用 Micorsoft Internet Controls。通过查看这个名称,我们知道它可以帮助我们控制 IE 页面。

二、网页操作

引用 Micorsoft Internet Controls 后,我们可以对页面做任何我们想做的事情,但是我们需要在主页上有一个页面,上帝说我们需要一个页面!

1、打开网页

我们以在百度上搜索“查虎”关键词为例:

With CreateObject("internetexplorer.application")

.Visible = True

.Navigate "https://www.baidu.com/s?wd=扯乎"

'关闭网页

' .Quit

End With

代码很简单,先创建一个IE对象,然后给一些属性赋值。Visible就是可见性,是指网页被操作时是否会看到网页。熟练后可以设置为False,这样不仅让程序在运行时有一种神秘感(而不是),而且速度也快了一点。

但是有一点要记住,这个网页在我们打开后并没有关闭,这意味着程序结束后需要手动关闭它。如果网页不可见,则无法手动关闭。代码中的注释部分用于关闭网页。不用说,导航就是 URL。

我们必须等待网页完全加载,然后才能开始信息抓取。这时候,我们使用:(从这里开始,所有的代码都需要写在With代码块中)

While .ReadyState 4 Or .Busy

DoEvents

Wend

Busy 是网页的繁忙状态,ReadyState 是 HTTP 的五种就绪状态,对应如下:

2、获取信息

我们先抓取页面上的所有内容,稍后过滤掉有用的部分,然后慢慢添加条件到抓取中。

Set dmt = .Document

For i = 0 To dmt.all.Length - 1

Set htMent = dmt.all(i)

With ActiveSheet

.Cells(i + 2, "A") = htMent.tagName

.Cells(i + 2, "B") = TypeName(htMent)

.Cells(i + 2, "C") = htMent.ID

.Cells(i + 2, "D") = htMent.Name

.Cells(i + 2, "E") = htMent.Value

.Cells(i + 2, "F") = htMent.Text

.Cells(i + 2, "G") = htMent.innerText

End With

Next i

这段代码有点类似于JS,需要从IE.Document.all中找出页面上的所有节点。还有其他几种方法:

这些更方便用于在抓取所有页面内容后帮助过滤有效信息。当然 all 最好用,因为 all 也有 all ("IDName") 和 all.IDName 的用法。

上面代码部分返回的属性值都是基本的HTML内容,就不一一解释了。

3、填写信息

爬网神器当然是Python。大多数人使用Excel自动填写页面内容,直接将表格提交到网页,省去了问卷录入等大量工作。抓取页面内容后,填充起来就更容易了。你只需要直接给页面标签的Value属性赋值即可。

但是,除了文本框,可能还有其他没有Value的标签,比如下拉菜单和单选按钮。给这些内容赋值需要一些基本的HTML知识。

'下拉菜单选择

.all("select")(0).Selected = True

'单选按钮选择

.all("radio").Checked = True

'复选按钮选择

.all("checkbox").Checked = True

下拉菜单是一个select标签,每个选项都在一个option标签中,所以要返回一个集合,需要选择一个选项,将对应的Selected属性修改为True。单选按钮和复选按钮都是输入标签。不同的是类型分别是radio和checkbox。要选择一个选项,您需要修改相应的 Checked 属性。

三、数据接口

有时我们可以直接获取一些API。当然,通过API返回数据比打开网页更方便快捷,使用的方法也有些不同。

1、请求接口

比如我得到了一个可以从网上查询到城市免费WIFI的API,我用下面的代码通过Excel界面访问:(虽然是免费的,为了避免麻烦,我还是隐藏了我的AppKey)

Dim http

Set http = CreateObject("Microsoft.XMLHTTP")

http.Open "GET", "http://api.avatardata.cn/Wifi/QueryByCity", False

http.setRequestHeader "CONTENT-TYPE", "application/x-www-form-urlencoded"

http.send "key=[AppKey]&city=北京&page=1"

这时候我们创建的对象不再是IE,而是HTTP对象。这里使用Ajax的Open方法,GET为数据发送方法,第二个参数为接口地址,第三个参数指定请求方法是否异步。如果这个API有账号和密码,就写在第四个和第五个参数中。

setRequestHeader是向接口发送一个HTTP协议头文件,最后发送的内容就是接口参数。当然,这个QueryString也可以直接写在URL中,发送一个空字符串即可。

2、接口返回

接口返回和获取的方式很简单:

If http.Status = 200 Then Range("A1").Value = http.responseText

excelvba抓取网页数据(Excel教程Excel函数Excel表格制作Excel2010Excel实用技巧Excel视频教程)

网站优化 • 优采云 发表了文章 • 0 个评论 • 99 次浏览 • 2021-10-04 05:15

在做这个项目时,我遇到了将表格数据存储在Excel网页中的问题。我将相关代码分享给你,希望对你有所帮助

出口:

<p>

function AutomateExcel()

{

//下面的这句代码要求浏览器是IE并且需要在Internet选项中设置选项,设置的步骤在最下面

var oXL = new ActiveXObject("Excel.Application"); //创建应该对象

var oWB = oXL.Workbooks.Add();//新建一个Excel工作簿

var oSheet = oWB.ActiveSheet;//指定要写入内容的工作表为活动工作表

var table = document.all.data;//指定要写入的数据源的id

var hang = table.rows.length;//取数据源行数

var lie = table.rows(0).cells.length;//取数据源列数

// Add table headers going cell by cell.

for (i=0;i 查看全部

excelvba抓取网页数据(Excel教程Excel函数Excel表格制作Excel2010Excel实用技巧Excel视频教程)

在做这个项目时,我遇到了将表格数据存储在Excel网页中的问题。我将相关代码分享给你,希望对你有所帮助

出口:

<p>

function AutomateExcel()

{

//下面的这句代码要求浏览器是IE并且需要在Internet选项中设置选项,设置的步骤在最下面

var oXL = new ActiveXObject("Excel.Application"); //创建应该对象

var oWB = oXL.Workbooks.Add();//新建一个Excel工作簿

var oSheet = oWB.ActiveSheet;//指定要写入内容的工作表为活动工作表

var table = document.all.data;//指定要写入的数据源的id

var hang = table.rows.length;//取数据源行数

var lie = table.rows(0).cells.length;//取数据源列数

// Add table headers going cell by cell.

for (i=0;i

excelvba抓取网页数据(vba网页元素代码抓取小工具【支持win10+】用IE提取网页资料)

网站优化 • 优采云 发表了文章 • 0 个评论 • 98 次浏览 • 2021-09-29 06:28

vba网页元素代码抓取小工具【支持win10+】

<p>使用IE提取网页信息的好处是:所见即所得,一般可以得到网页上能看到的信息。这个工具功能不多,主要是方便提取网页显示信息所在元素的代码。我希望我能帮到你一点点。网页爬虫widget.rar (22.91 KB, 下载: 3601) 如何使用这个工具:1、在B1中输入网址,可以是打开的网页也可以是2、A2和B2未打开的内容,不要改,第二行其他单元格可以自己输入元素的属性名称,其中,innertext单元格有一个下拉选项< @3、 并点击“开始”“分析”分析网页元素。< @4、A 列是每个元素的对象代码。5、 在innertext列中找到要提取的内容后,选中该行,点击“生成excel”。表格可以提取标签形式或下载 IMG 标签图像。6、 在新生成的excel中,点击“执行代码”按钮,看看是否可以生成需要的数据。如果生成的数据与分析的数据不匹配,原因可能是:1、网页未完全加载,对应标签的数据尚未加载,代码自动提取后续标签数据。可能的解决方法:添加do...loop time delay。2、 网页为动态网页,标签号不确定。可能的解决方案:如果元素有一个 id 名称,则使用 getelementbyid("id name" ) 获取它,如果没有,则抓取该包并使用 xmlhttp 提取它。 查看全部

excelvba抓取网页数据(vba网页元素代码抓取小工具【支持win10+】用IE提取网页资料)

vba网页元素代码抓取小工具【支持win10+】

<p>使用IE提取网页信息的好处是:所见即所得,一般可以得到网页上能看到的信息。这个工具功能不多,主要是方便提取网页显示信息所在元素的代码。我希望我能帮到你一点点。网页爬虫widget.rar (22.91 KB, 下载: 3601) 如何使用这个工具:1、在B1中输入网址,可以是打开的网页也可以是2、A2和B2未打开的内容,不要改,第二行其他单元格可以自己输入元素的属性名称,其中,innertext单元格有一个下拉选项< @3、 并点击“开始”“分析”分析网页元素。< @4、A 列是每个元素的对象代码。5、 在innertext列中找到要提取的内容后,选中该行,点击“生成excel”。表格可以提取标签形式或下载 IMG 标签图像。6、 在新生成的excel中,点击“执行代码”按钮,看看是否可以生成需要的数据。如果生成的数据与分析的数据不匹配,原因可能是:1、网页未完全加载,对应标签的数据尚未加载,代码自动提取后续标签数据。可能的解决方法:添加do...loop time delay。2、 网页为动态网页,标签号不确定。可能的解决方案:如果元素有一个 id 名称,则使用 getelementbyid("id name" ) 获取它,如果没有,则抓取该包并使用 xmlhttp 提取它。

excelvba抓取网页数据(百度中搜索关键字:网络爬虫写入当前Excel工作表 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 120 次浏览 • 2021-09-24 06:08

)

在百度中搜索关键词“网络爬虫”,将查询结果前5页的数据写入当前Excel工作表中。示例代码如下。

Sub WebQueryBaiduPN()

Dim strURL As String

Dim objXMLHTTP As Object

Dim objDOM As Object

Dim objTitle As Object

Dim intPageNum As Integer

Dim k As Integer

Set objXMLHTTP = CreateObject("MSXML2.XMLHTTP")

Set objDOM = CreateObject("htmlfile")

Cells.ClearContents

Range("a1:c1") = Array("序号", "标题", "链接")

k = 1

For intPageNum = 0 To 50 Step 10

strURL = "https://www.baidu.com/s?"

strURL = strURL & "wd=网络爬虫"

strURL = strURL & "&pn=" & intPageNum

With objXMLHTTP

.Open "GET", strURL, False

.setRequestHeader "If-Modified-Since", "0"

.send

objDOM.body.innerHTML = .responseText

End With

For Each objTitle In objDOM.getElementsByTagName("h3")

k = k + 1

Cells(k, 1) = k - 1

With objTitle.getElementsByTagName("a")(0)

Cells(k, 2) = .innerText

Cells(k, 3) = .href

End With

Next objTitle

Next intPageNum

Set objXMLHTTP = Nothing

Set objDOM = Nothing

Set objTitle = Nothing

End Sub

第16行代码指定获取百度查询结果的页数。通过手动翻百度网页页面,观察Fiddler软件请求框中【WebForms】界面参数的变化,可以发现参数pn代表查询结果的页码。该参数每增加10,网页每增加10更新一次。

代码第17-22行使用MSXML2.XMLHTTP对象发送请求数据,并将获取到的响应信息写入HTML DOM对象的Body标签中。

第 19 行代码指定了请求头域 If-Modified-Since。由于XSXML2.XMLHTTP对象会优先从Excel或IE缓存中读取数据,因此在刷新互联网浏览器数据但未删除缓存时,无法获取网页的最新数据。

If-Modified-Since 是标准的 HTTP 请求标头。发送HTTP请求时,会将浏览器缓存页面的最后修改时间发送给服务器,服务器会将此时间与实际文件的最后修改时间进行比较。

如果时间相同,服务器返回HTTP状态码304而不是文件内容。客户端收到信息后,将本地缓存文件加载到浏览器中。此时,MSXML2.XMLHTTP 对象实际上读取了本地缓存的数据。

相反,如果时间不一致,服务器返回 HTTP 状态码 200 和新文件内容。客户端收到信息后,丢弃旧文件,缓存新文件,加载到浏览器中。此时,MSXML2.XMLHTTP 对象读取服务器发送的新数据。

第23-30行遍历HTML DOM对象的h3标签,是百度网页的三级标题。

第26行至第29行代码分别获取标签下标签为a的第一个子节点的文本内容和链接URL。

运行过程的部分结果如下。

查看全部

excelvba抓取网页数据(百度中搜索关键字:网络爬虫写入当前Excel工作表

)

在百度中搜索关键词“网络爬虫”,将查询结果前5页的数据写入当前Excel工作表中。示例代码如下。

Sub WebQueryBaiduPN()

Dim strURL As String

Dim objXMLHTTP As Object

Dim objDOM As Object

Dim objTitle As Object

Dim intPageNum As Integer

Dim k As Integer

Set objXMLHTTP = CreateObject("MSXML2.XMLHTTP")

Set objDOM = CreateObject("htmlfile")

Cells.ClearContents

Range("a1:c1") = Array("序号", "标题", "链接")

k = 1

For intPageNum = 0 To 50 Step 10

strURL = "https://www.baidu.com/s?"

strURL = strURL & "wd=网络爬虫"

strURL = strURL & "&pn=" & intPageNum

With objXMLHTTP

.Open "GET", strURL, False

.setRequestHeader "If-Modified-Since", "0"

.send

objDOM.body.innerHTML = .responseText

End With

For Each objTitle In objDOM.getElementsByTagName("h3")

k = k + 1

Cells(k, 1) = k - 1

With objTitle.getElementsByTagName("a")(0)

Cells(k, 2) = .innerText

Cells(k, 3) = .href

End With

Next objTitle

Next intPageNum

Set objXMLHTTP = Nothing

Set objDOM = Nothing

Set objTitle = Nothing

End Sub

第16行代码指定获取百度查询结果的页数。通过手动翻百度网页页面,观察Fiddler软件请求框中【WebForms】界面参数的变化,可以发现参数pn代表查询结果的页码。该参数每增加10,网页每增加10更新一次。

代码第17-22行使用MSXML2.XMLHTTP对象发送请求数据,并将获取到的响应信息写入HTML DOM对象的Body标签中。

第 19 行代码指定了请求头域 If-Modified-Since。由于XSXML2.XMLHTTP对象会优先从Excel或IE缓存中读取数据,因此在刷新互联网浏览器数据但未删除缓存时,无法获取网页的最新数据。

If-Modified-Since 是标准的 HTTP 请求标头。发送HTTP请求时,会将浏览器缓存页面的最后修改时间发送给服务器,服务器会将此时间与实际文件的最后修改时间进行比较。

如果时间相同,服务器返回HTTP状态码304而不是文件内容。客户端收到信息后,将本地缓存文件加载到浏览器中。此时,MSXML2.XMLHTTP 对象实际上读取了本地缓存的数据。

相反,如果时间不一致,服务器返回 HTTP 状态码 200 和新文件内容。客户端收到信息后,丢弃旧文件,缓存新文件,加载到浏览器中。此时,MSXML2.XMLHTTP 对象读取服务器发送的新数据。

第23-30行遍历HTML DOM对象的h3标签,是百度网页的三级标题。

第26行至第29行代码分别获取标签下标签为a的第一个子节点的文本内容和链接URL。

运行过程的部分结果如下。

excelvba抓取网页数据(轻松用Excel获取网页数据的一些初步的爬虫方法(图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 626 次浏览 • 2021-09-24 06:06

我们通常使用 Excel,并且经常处理本地数据。您知道如何在 Excel 中进行排序、筛选、条件格式、数据透视表、图表等……但您可能不了解 Excel 是如何获取网页数据的!

网络爬虫?!您可能认为您必须编写代码来实现这一点。其实除了代码,Excel还有一些现成的功能,让你不用代码也能获取网页的数据!

下面的方法中,前三个不需要写代码,最后一个需要代码,但是我已经写好了,可以用了,所以你也可以学习轻松使用Excel来获取一些网页爬虫的初步页面数据方法!

函数方法

从 Excel 2013 版本开始,引入了一些 Web 功能。下面两个函数可以配合使用,帮助我们把网页的数据获取到Excel中。

FILTERXML(xml, xpath),从 XML 数据中返回指定的数据。网页上的许多数据都以 XML 的形式存在。该函数用于提取 XML 中的指定信息。

WEBSERVICE(url),返回网页中的数据,可以理解为这个函数可以得到一堆XML字符串数据。

例如下面的公式使用有道的网站得到翻译结果:

=FILTERXML(WEBSERVICE(";i="&B2&"&doctype=xml&version"),"//翻译")

如果你把上面的公式复制到Excel,你只需要在B2单元格输入你要翻译的内容,公式就会把翻译好的结果返回给你!

是不是感觉超级方便!对于外部数据的轻量级连接,这个函数方法是相当方便的。

除了翻译,使用此功能还可以协助您进行股票交易!我在工作,不方便使用手机或看财经网页,但我想关注实时股价。怎么破解?

把下面的公式复制到B1单元格,然后在A1单元格输入你关注的股票代码,B1可以显示实时股价,想刷新就按F9~

=VALUE(TRIM(MID(SUBSTITUTE(WEBSERVICE(""&A1&"&time="&TEXT(NOW(),"hhmmss")),",",REPT("",99)),2* 99,111)))

当你全神贯注地看着Excel工作(chao)为(gu)时,即使老板突然经过,你也能从容应对!不要让你的老板知道这个技能!

但是你也需要注意使用这个公式。首先,您必须确保您的计算机可以正常连接到互联网。另外,如果有道调整了网页代码或更改了URL入口,则上述公式也将失效。你需要再研究一下逻辑。写公式~

旧版网页查询功能

Excel2016之前一直有获取网页数据的功能,在Excel2016推出PQ后隐藏了,但是还是可以手动调出!

手动调用的方法可以在“选项”中的“数据”中设置其显示,也可以直接按快捷键Alt+D+D+W(注意:在同时,只需按顺序按即可!),然后会弹出如下界面:

然后我们只需要输入网页地址即可。图中地址为#06f01。

这个功能可以帮助我们识别网页中的表格,然后我们只需要选中表格(点击黄色箭头选择),点击右下角的导入,然后将数据导入到Excel中即可!

而且还可以刷新这张表,同时支持手动刷新和自动刷新,非常方便~

这种方法的问题是不是所有的网页都能获取到数据,因为你可能无法获取到真实的网址,所以你应该尽量找到最深入的地址。你有爬取的方法,别人有反爬取的方法,所以如果继续获取网页上的数据,需要密切关注网页是否发生了变化~

Power Query 获取网页数据

从 Excel 2016 开始,PQ 已经集成到 Excel 中,并计划用它来代替旧版本的数据查询和获取功能,所以使用 PQ 也可以帮助我们获取网页的数据!

由于动画太大无法上传,我将使用截图来说明步骤:

1、 点击上面的“From 网站”,输入网址,点击“OK”

2、 在出现的导航器中,点击Table开头的图标,右边会有这些表格的预览,选择要导入的表格,点击右下角的“Load”角落

3、 然后就可以把表格数据导出到Excel了,还支持手动刷新和自动刷新!

VBA代码方法

其实以上方法都算不上真正的“爬虫”技巧。如果想更灵活地获取数据,就需要使用VBA代码。

使用VBA获取网页数据,当然也可以结合以上三种方式使用,因为写代码意味着可以判断和循环,就像上面的股票收盘价信息一样,通过循环可以得到多个股票数据会更方便!

比如用VBA调用第二种方法,结合Excel的基本功能对数据进行排序和提取,就可以实现历史天气数据的获取!下面的方法使用VBA获取天气数据~

对于零售业来说,天气确实是一个非常重要的因素,会影响客流和季节性商品的销售。因此,有必要对历史天气数据进行分析!

如何批量获取天气数据?以下是获取北京2019年11月历史天气数据的结果:

这需要使用 VBA 代码。以上方法不适合大量获取数据。不会打码?没关系,我已经写好了,也有解释。复制后,稍加修改即可使用。(代码在文末)

如果你还想获取多个城市、多个年份、多个月份的数据,那么你需要考虑更多的情况。可以根据文末提供的代码修改实现。 查看全部

excelvba抓取网页数据(轻松用Excel获取网页数据的一些初步的爬虫方法(图))

我们通常使用 Excel,并且经常处理本地数据。您知道如何在 Excel 中进行排序、筛选、条件格式、数据透视表、图表等……但您可能不了解 Excel 是如何获取网页数据的!

网络爬虫?!您可能认为您必须编写代码来实现这一点。其实除了代码,Excel还有一些现成的功能,让你不用代码也能获取网页的数据!

下面的方法中,前三个不需要写代码,最后一个需要代码,但是我已经写好了,可以用了,所以你也可以学习轻松使用Excel来获取一些网页爬虫的初步页面数据方法!

函数方法

从 Excel 2013 版本开始,引入了一些 Web 功能。下面两个函数可以配合使用,帮助我们把网页的数据获取到Excel中。

FILTERXML(xml, xpath),从 XML 数据中返回指定的数据。网页上的许多数据都以 XML 的形式存在。该函数用于提取 XML 中的指定信息。

WEBSERVICE(url),返回网页中的数据,可以理解为这个函数可以得到一堆XML字符串数据。

例如下面的公式使用有道的网站得到翻译结果:

=FILTERXML(WEBSERVICE(";i="&B2&"&doctype=xml&version"),"//翻译")

如果你把上面的公式复制到Excel,你只需要在B2单元格输入你要翻译的内容,公式就会把翻译好的结果返回给你!

是不是感觉超级方便!对于外部数据的轻量级连接,这个函数方法是相当方便的。

除了翻译,使用此功能还可以协助您进行股票交易!我在工作,不方便使用手机或看财经网页,但我想关注实时股价。怎么破解?

把下面的公式复制到B1单元格,然后在A1单元格输入你关注的股票代码,B1可以显示实时股价,想刷新就按F9~

=VALUE(TRIM(MID(SUBSTITUTE(WEBSERVICE(""&A1&"&time="&TEXT(NOW(),"hhmmss")),",",REPT("",99)),2* 99,111)))

当你全神贯注地看着Excel工作(chao)为(gu)时,即使老板突然经过,你也能从容应对!不要让你的老板知道这个技能!

但是你也需要注意使用这个公式。首先,您必须确保您的计算机可以正常连接到互联网。另外,如果有道调整了网页代码或更改了URL入口,则上述公式也将失效。你需要再研究一下逻辑。写公式~

旧版网页查询功能

Excel2016之前一直有获取网页数据的功能,在Excel2016推出PQ后隐藏了,但是还是可以手动调出!

手动调用的方法可以在“选项”中的“数据”中设置其显示,也可以直接按快捷键Alt+D+D+W(注意:在同时,只需按顺序按即可!),然后会弹出如下界面:

然后我们只需要输入网页地址即可。图中地址为#06f01。

这个功能可以帮助我们识别网页中的表格,然后我们只需要选中表格(点击黄色箭头选择),点击右下角的导入,然后将数据导入到Excel中即可!

而且还可以刷新这张表,同时支持手动刷新和自动刷新,非常方便~

这种方法的问题是不是所有的网页都能获取到数据,因为你可能无法获取到真实的网址,所以你应该尽量找到最深入的地址。你有爬取的方法,别人有反爬取的方法,所以如果继续获取网页上的数据,需要密切关注网页是否发生了变化~

Power Query 获取网页数据

从 Excel 2016 开始,PQ 已经集成到 Excel 中,并计划用它来代替旧版本的数据查询和获取功能,所以使用 PQ 也可以帮助我们获取网页的数据!

由于动画太大无法上传,我将使用截图来说明步骤:

1、 点击上面的“From 网站”,输入网址,点击“OK”

2、 在出现的导航器中,点击Table开头的图标,右边会有这些表格的预览,选择要导入的表格,点击右下角的“Load”角落

3、 然后就可以把表格数据导出到Excel了,还支持手动刷新和自动刷新!

VBA代码方法

其实以上方法都算不上真正的“爬虫”技巧。如果想更灵活地获取数据,就需要使用VBA代码。

使用VBA获取网页数据,当然也可以结合以上三种方式使用,因为写代码意味着可以判断和循环,就像上面的股票收盘价信息一样,通过循环可以得到多个股票数据会更方便!

比如用VBA调用第二种方法,结合Excel的基本功能对数据进行排序和提取,就可以实现历史天气数据的获取!下面的方法使用VBA获取天气数据~

对于零售业来说,天气确实是一个非常重要的因素,会影响客流和季节性商品的销售。因此,有必要对历史天气数据进行分析!

如何批量获取天气数据?以下是获取北京2019年11月历史天气数据的结果:

这需要使用 VBA 代码。以上方法不适合大量获取数据。不会打码?没关系,我已经写好了,也有解释。复制后,稍加修改即可使用。(代码在文末)

如果你还想获取多个城市、多个年份、多个月份的数据,那么你需要考虑更多的情况。可以根据文末提供的代码修改实现。

excelvba抓取网页数据(如何获取百度查询结果——百度抓取结果的个数 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 106 次浏览 • 2021-09-24 06:06

)

当用户通过网络浏览器登录互联网时,他会向网络服务器请求某个网页。服务器收到请求后,会响应,将设置好的页面文件发送到浏览器的显示界面。这是一个完整的网页请求和处理的过程。Netscrape 尝试在代码过程中模拟这种交互过程。

首先,在 Excel 中使用 VBA 来捕获 网站 数据。

其次,无论是使用Python、java还是VBA进行网页抓取,都需要对HTTP协议、HTML(HyperTextMarkup Language)和DOM(文档对象模型)有初步的了解。

此外,还介绍了一个软件 Fiddler。网络爬虫的成功需要准确真实的URL,模拟正确的请求消息,分析服务器响应请求后返回的信息,这些数据可以通过Fiddler软件获取。通过 Fiddler 很容易找到内容所在的 URL。

今天简单介绍一下如何获取百度查询结果——抓取的百度查询结果数量。

1.首先打开Fiddler软件,在浏览器中打开百度网站,搜索关键词“网络爬虫”。

2.在Fiddler软件中搜索“百度为你找到相关结果”,如下图。

3. 点击对话框中的第一个黄色数据,点击右侧Request框中的【Raw】按钮,可以查看发送请求的HTTP报文的详细数据。第一行是请求行,内容如下。

GET https://www.baidu.com/s%3Fwd%3 ... D6639 HTTP/1.1

开头的GET为请求方法字段,结尾的HTTP/1.1为协议版本字段,其余信息为URL字段。由于请求行使用 GET 方法,因此请求数据将附加到 URL。URL和请求数据用“?”分隔,多个参数用“&”连接。

虽然传输数据的参数很多,但并不是所有的参数都是必须的。在Request框中选择【WebForms】选项卡,可以查看多个参数的Name和对应的Value。百度搜索到的关键词“网络爬虫”位于参数wd下,如下图所示。因此,URL 可以简明如下。

网络爬虫

4. 在Request框中点击【Raw】按钮查看响应报文的详细数据,点击框右下角的【在记事本中查看】按钮将相关数据转换为记事本文件格式。在记事本中搜索关键词“百度为你找到了相关结果”,即可查看收录该关键词的相关数据。

示例代码如下。

<p>Sub WebQueryBaidu()

Dim objXMLHTTP As Object

Dim strURL As String

Dim strText As String

Set objXMLHTTP = CreateObject("MSXML2.XMLHTTP")

With objXMLHTTP

strURL = "https://www.baidu.com/s?wd=网络爬虫"

.Open "GET", strURL, False

.send

strText = .responseText

End With

Range("a1") = "百度:excelhome 结果个数为:"

Range("a2") = Split(Split(strText, "百度为您找到相关结果")(1), " 查看全部

excelvba抓取网页数据(如何获取百度查询结果——百度抓取结果的个数

)

当用户通过网络浏览器登录互联网时,他会向网络服务器请求某个网页。服务器收到请求后,会响应,将设置好的页面文件发送到浏览器的显示界面。这是一个完整的网页请求和处理的过程。Netscrape 尝试在代码过程中模拟这种交互过程。

首先,在 Excel 中使用 VBA 来捕获 网站 数据。

其次,无论是使用Python、java还是VBA进行网页抓取,都需要对HTTP协议、HTML(HyperTextMarkup Language)和DOM(文档对象模型)有初步的了解。

此外,还介绍了一个软件 Fiddler。网络爬虫的成功需要准确真实的URL,模拟正确的请求消息,分析服务器响应请求后返回的信息,这些数据可以通过Fiddler软件获取。通过 Fiddler 很容易找到内容所在的 URL。

今天简单介绍一下如何获取百度查询结果——抓取的百度查询结果数量。

1.首先打开Fiddler软件,在浏览器中打开百度网站,搜索关键词“网络爬虫”。

2.在Fiddler软件中搜索“百度为你找到相关结果”,如下图。

3. 点击对话框中的第一个黄色数据,点击右侧Request框中的【Raw】按钮,可以查看发送请求的HTTP报文的详细数据。第一行是请求行,内容如下。

GET https://www.baidu.com/s%3Fwd%3 ... D6639 HTTP/1.1

开头的GET为请求方法字段,结尾的HTTP/1.1为协议版本字段,其余信息为URL字段。由于请求行使用 GET 方法,因此请求数据将附加到 URL。URL和请求数据用“?”分隔,多个参数用“&”连接。

虽然传输数据的参数很多,但并不是所有的参数都是必须的。在Request框中选择【WebForms】选项卡,可以查看多个参数的Name和对应的Value。百度搜索到的关键词“网络爬虫”位于参数wd下,如下图所示。因此,URL 可以简明如下。

网络爬虫

4. 在Request框中点击【Raw】按钮查看响应报文的详细数据,点击框右下角的【在记事本中查看】按钮将相关数据转换为记事本文件格式。在记事本中搜索关键词“百度为你找到了相关结果”,即可查看收录该关键词的相关数据。

示例代码如下。

<p>Sub WebQueryBaidu()

Dim objXMLHTTP As Object

Dim strURL As String

Dim strText As String

Set objXMLHTTP = CreateObject("MSXML2.XMLHTTP")

With objXMLHTTP

strURL = "https://www.baidu.com/s?wd=网络爬虫"

.Open "GET", strURL, False

.send

strText = .responseText

End With

Range("a1") = "百度:excelhome 结果个数为:"

Range("a2") = Split(Split(strText, "百度为您找到相关结果")(1), "

excelvba抓取网页数据( Excelvba如何抓取指定的网页数据到单元格/>1)

网站优化 • 优采云 发表了文章 • 0 个评论 • 298 次浏览 • 2021-09-19 12:09

Excelvba如何抓取指定的网页数据到单元格/>1)

Sub getHTML()<br /><br />Dim http<br />Set http = CreateObject("Msxml2.ServerXMLHTTP")<br />http.Open "GET", "https://zhidao.baidu.com/quest ... ot%3B, False<br />http.send<br />Debug.Print http.Status<br />Debug.Print http.responsetext<br /><br />End Sub

Excel VBA如何将指定的网页数据抓取到单元格“/>

1、打开excel,单击“数据”和“新建web查询”。来吧

2、在互联网上搜索列表,复制网站并单击“go”

3、单击“隐藏图标”,选择此列表,单击“导入”源,然后单击“确定”导入数据

4、如果要查询实时数据,请在粘贴区域右键单击鼠标,然后单击“刷新”完成。下面将显示后台查询、将网页内容复制到表中等

如果这

您必须熟悉Excel中的VBA

您可以在Excel home中询问一些VBA专家

在这里很难见面

看来你对基础有点了解。一点学习,然后结合VBA就可以了

此文章标记:从excel中提取网页元素(1)excel自动提取网页数据(1))@ 查看全部

excelvba抓取网页数据(

Excelvba如何抓取指定的网页数据到单元格/>1)

Sub getHTML()<br /><br />Dim http<br />Set http = CreateObject("Msxml2.ServerXMLHTTP")<br />http.Open "GET", "https://zhidao.baidu.com/quest ... ot%3B, False<br />http.send<br />Debug.Print http.Status<br />Debug.Print http.responsetext<br /><br />End Sub

Excel VBA如何将指定的网页数据抓取到单元格“/>

1、打开excel,单击“数据”和“新建web查询”。来吧

2、在互联网上搜索列表,复制网站并单击“go”

3、单击“隐藏图标”,选择此列表,单击“导入”源,然后单击“确定”导入数据

4、如果要查询实时数据,请在粘贴区域右键单击鼠标,然后单击“刷新”完成。下面将显示后台查询、将网页内容复制到表中等

如果这

您必须熟悉Excel中的VBA

您可以在Excel home中询问一些VBA专家

在这里很难见面

看来你对基础有点了解。一点学习,然后结合VBA就可以了

此文章标记:从excel中提取网页元素(1)excel自动提取网页数据(1))@

excelvba抓取网页数据(专题“利用IE抓取网络数据”的第二节(图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 72 次浏览 • 2021-09-18 23:15

各位好。今天,我们将解释“VBA信息获取和处理”教程“使用IE捕获股票”中第九个主题“通过IE捕获网络数据”的第二部分,这是一个非常有用的知识点。我希望你能掌握它

第二节利用IE捕捉主要资本流入的存量

大家好,让我们从使用IE控件捕获网络数据的任务开始。由于基础知识已经解释了很多,这里的代码解释将更简单。您可以参考我给出的代码注释来理解

实施场景:当我们进行股票分析时,我们最关心的是基金的趋势。是否有大量资本流入是大多数散户投资者投资股票的重要依据。我们以《财富》网站提供的主要资本流入的股票数据作为数据提取的依据。该网站为:/zjlx/

1利用IE获取主要资本流入数据的思路分析

为了捕获数据,让我们首先看看web页面。以下是2020年6月11日网页提供的数据:

我们的任务是将上述数据捕获到excel表格中。为了使用IE进行数据捕获,我们首先需要创建一个IE引用CreateObject(“InternetExplorer.Application”)。然后,ie打开给定的web地址并单击。导航“/zjlx/”已实现。我们从网页上得到该表的序列号为5,然后提取该表中的数据。您可以回顾我以前关于表的知识。从web文档中提取文档对象,使用dmt.all.tags(“表”)(5)查找表,然后使用TB.Rows(I).Cells(J).InnerText输出数据

2使用IE实现主要资本流入数据捕获的代码

为了实现上述想法,我给出了以下代码:

Sub mynz()'使用IE捕获主要资本流入的股票

Dim ie、dmt、tb、i&;、j&

设置MyIE=CreateObject(“internetexplorer.Application”)'创建IE对象

图纸(“图纸1”)。选择

行(“3:100”)。ClearContents

和myIE在一起

.visible=true“显示它

.navigate“/zjlx/”加载东风财富网的主要资金流入

直到.ReadyState=4'检查网页是否已加载(4表示满载)

在“Doevents”循环中将工作权限返回给系统,以避免“软崩溃”

环路

Set DMT=.Document'将IE浏览器加载的页面文档分配给DMT变量

设置TB=dmt.all.tags(“table”)(5)'按索引号捕获表对象

对于I=2到tb.rows.length,通过其每行的长度为-1'

对于J=0到TB.Rows(I).Cells.Length-1'通过每行中的每个单元格

单元格(I+1,j+1)=“””和TB.Rows(I).Cells(j).InnerText”将其InnerText写入单元格

下一个

下一个

以

MsgBox(“OK”)

端接头

代码截图:

代码分析:

1)SetMyIE=CreateObject(“Internet Explorer.Application”)此代码用于创建IE对象或更高版本的绑定。可以使用引用

2)板材(“板材1”)。选择

行(“3:100”)。ClearContents

清除要填充的数据区域

3)和myIE

.visible=true“显示它

.导航“/zjlx/”

以上代码加载ie中的“/zjlx/”网站,即东风财富网的主要资金流入

4)do until.ReadyState=4'检查网页是否已加载(4表示满载)

在“Doevents”循环中将工作权限返回给系统,以避免“软崩溃”

环路

这段代码是让网页加载,以便以后提取网页的数据

5)SetDMT=.Document'将IE浏览器加载的页面文档分配给DMT变量,其中DMT是一个对象变量

6)set TB=DMT.All.Tags(“table”)(5))通过索引号捕获表对象。此处的序列号来自我们对网页的分析。您还可以使用工具分析网页

7)ForI=2到tb.rows.length-1'通过其每一行

对于J=0到TB.Rows(I).Cells.Length-1'通过每行中的每个单元格

单元格(I+1,j+1)=“””和TB.Rows(I).Cells(j).InnerText”将其InnerText写入单元格

下一个

下一个

提取表的数据,其中TB.Rows.Length–1是行数;TB.Rows(I).Cells(J).InnerText是单元格的内容

3.应用IE获取主要资本流入数据

我们单击页面上的“运行”按钮以捕获以下数据:

从实施效果来看,完全满足我们的场景需求

回到本节中的知识点:如何从页面文档中提取表数据

有关本节内容,请参阅009工作表.xlsm

构建块编程的思想和内涵:

在我的系列书籍中,我一直强调“积木”的编程思想,这也是学习和使用VBA的主要方法,尤其是对于专业人士而言。其主要内涵是:

1.不要自己输入所有代码。你要做的是将构建块放在正确的位置,然后更正代码。一定要复制它,从构建块库复制它,然后更正代码,以便利用你的时间进行有效思考

2.建立你自己的“积木库”。在学习过程中,把你认为有用的代码放在一起,积累更多,你可以在任何时候使用它。积木库中的信息越多,你在制作程序时的想法就越多

VBA的应用定义

VBA是利用office实现个人小型办公自动化的有效手段(工具)。这是我对VBA应用的定义。在取代office的新办公软件到来之前,谁能在数据处理方面取得最好成绩,谁就是王者。其中,VBA是最强大的技能

我记得20年前我第一次学习VBA时,材料很少。我只能看源代码,自己思考。这真的很难。20年后,为了不让我的朋友学习VBA重复我以前的经验,我在多年实践VBA的基础上开设了六门VBA特别课程经验:

第一套:VBA代码解决方案是解释VBA中的各种知识点。本教程共有147节课,涵盖了绝大多数VBA知识点,这是初学者所必需的

第二套:VBA数据库解决方案数据库是数据处理的专业工具,本教程详细介绍了用ADO连接accdb和excel的方法和示例操作,适合中级人员使用

第三套:VBA数组和字典解决方案数组和字典是VBA的精髓。字典是提高VBA代码水平的有效手段,值得深入学习。它是高级和中级人员代码的一种手段

第四套:VBA代码解决方案视频是针对初学者的视频讲解,可以快速入门,更快掌握这项技能。这套教程是第一套教程的视频讲解,更容易听元音

第五套:VBA中的课堂解读与运用。这是一门解释课堂虚无和肉体程度的高级课程。虽然课堂运用较少,但认真学习可以促进自身VBA理论的完善。对这套课程的理解主要是对f读者与一种佛教哲学

第六套教程:VBA信息获取与处理,这是一门高级课程,涵盖范围更广,对中高级人员更实用。该课程有20个主题,包括:跨应用程序信息获取、随机信息的利用、电子邮件发送、VBA Internet数据捕获、VBA delay操作、剪贴板应用程序、拆分功能扩展、工作表信息与其他应用程序的交互、FSO对象的使用、工作表和文件夹信息获取、图形信息获取和自定义工作表信息功能等

根据以上信息,您可以按照1的顺序逐步学习→ 3.→ 2.→ 6.→ 5或4→ 3.→ 2.→ 6.→ 5.本教程提供了说明和大量构建块。如果需要,您可以微信:nz9668

学习VBA是一个过程,也需要经历一种无聊的感觉

正如太白的诗所说:鸟儿高飞,寂寞的云朵独自消遣。你们不会厌倦彼此的相见,只有静亭山。学习的过程也是培养心灵的过程,培养一颗平静的心。在密码的世界里,当你的心灵平静时,你的身体自然会很好。当你平静时,你会很好没错。如果你心中没有那么多邪恶的知识和观点,你就不会有那么多妄想。对别人有益是自利。这些教程也是帮助你启航和帮助我的。我上面的教程是我的经验的传递

“水对万物都有好处,没有争议"学习也是一样。你知道你需要什么。不要蜷缩在一个你认为是天堂的小世界里。不要欺骗自己和他人,直到你年老。努力提高自己,用充满活力的心和精神把握现在。这是进步。事情越有意义,困难就越多。愿意做决定n智慧决定成败。无论你遇到什么,它都是一道风景。忽视争端,轻视得失。不管茶是满的还是小的,浓的还是淡的,它都有自己的味道值得品尝。去f 查看全部

excelvba抓取网页数据(专题“利用IE抓取网络数据”的第二节(图))

各位好。今天,我们将解释“VBA信息获取和处理”教程“使用IE捕获股票”中第九个主题“通过IE捕获网络数据”的第二部分,这是一个非常有用的知识点。我希望你能掌握它

第二节利用IE捕捉主要资本流入的存量

大家好,让我们从使用IE控件捕获网络数据的任务开始。由于基础知识已经解释了很多,这里的代码解释将更简单。您可以参考我给出的代码注释来理解

实施场景:当我们进行股票分析时,我们最关心的是基金的趋势。是否有大量资本流入是大多数散户投资者投资股票的重要依据。我们以《财富》网站提供的主要资本流入的股票数据作为数据提取的依据。该网站为:/zjlx/

1利用IE获取主要资本流入数据的思路分析

为了捕获数据,让我们首先看看web页面。以下是2020年6月11日网页提供的数据:

我们的任务是将上述数据捕获到excel表格中。为了使用IE进行数据捕获,我们首先需要创建一个IE引用CreateObject(“InternetExplorer.Application”)。然后,ie打开给定的web地址并单击。导航“/zjlx/”已实现。我们从网页上得到该表的序列号为5,然后提取该表中的数据。您可以回顾我以前关于表的知识。从web文档中提取文档对象,使用dmt.all.tags(“表”)(5)查找表,然后使用TB.Rows(I).Cells(J).InnerText输出数据

2使用IE实现主要资本流入数据捕获的代码

为了实现上述想法,我给出了以下代码:

Sub mynz()'使用IE捕获主要资本流入的股票

Dim ie、dmt、tb、i&;、j&

设置MyIE=CreateObject(“internetexplorer.Application”)'创建IE对象

图纸(“图纸1”)。选择

行(“3:100”)。ClearContents

和myIE在一起

.visible=true“显示它

.navigate“/zjlx/”加载东风财富网的主要资金流入

直到.ReadyState=4'检查网页是否已加载(4表示满载)

在“Doevents”循环中将工作权限返回给系统,以避免“软崩溃”

环路

Set DMT=.Document'将IE浏览器加载的页面文档分配给DMT变量

设置TB=dmt.all.tags(“table”)(5)'按索引号捕获表对象

对于I=2到tb.rows.length,通过其每行的长度为-1'

对于J=0到TB.Rows(I).Cells.Length-1'通过每行中的每个单元格

单元格(I+1,j+1)=“””和TB.Rows(I).Cells(j).InnerText”将其InnerText写入单元格

下一个

下一个

以

MsgBox(“OK”)

端接头

代码截图:

代码分析:

1)SetMyIE=CreateObject(“Internet Explorer.Application”)此代码用于创建IE对象或更高版本的绑定。可以使用引用

2)板材(“板材1”)。选择

行(“3:100”)。ClearContents

清除要填充的数据区域

3)和myIE

.visible=true“显示它

.导航“/zjlx/”

以上代码加载ie中的“/zjlx/”网站,即东风财富网的主要资金流入

4)do until.ReadyState=4'检查网页是否已加载(4表示满载)

在“Doevents”循环中将工作权限返回给系统,以避免“软崩溃”

环路

这段代码是让网页加载,以便以后提取网页的数据

5)SetDMT=.Document'将IE浏览器加载的页面文档分配给DMT变量,其中DMT是一个对象变量

6)set TB=DMT.All.Tags(“table”)(5))通过索引号捕获表对象。此处的序列号来自我们对网页的分析。您还可以使用工具分析网页

7)ForI=2到tb.rows.length-1'通过其每一行

对于J=0到TB.Rows(I).Cells.Length-1'通过每行中的每个单元格

单元格(I+1,j+1)=“””和TB.Rows(I).Cells(j).InnerText”将其InnerText写入单元格

下一个

下一个

提取表的数据,其中TB.Rows.Length–1是行数;TB.Rows(I).Cells(J).InnerText是单元格的内容

3.应用IE获取主要资本流入数据

我们单击页面上的“运行”按钮以捕获以下数据:

从实施效果来看,完全满足我们的场景需求

回到本节中的知识点:如何从页面文档中提取表数据

有关本节内容,请参阅009工作表.xlsm

构建块编程的思想和内涵:

在我的系列书籍中,我一直强调“积木”的编程思想,这也是学习和使用VBA的主要方法,尤其是对于专业人士而言。其主要内涵是:

1.不要自己输入所有代码。你要做的是将构建块放在正确的位置,然后更正代码。一定要复制它,从构建块库复制它,然后更正代码,以便利用你的时间进行有效思考

2.建立你自己的“积木库”。在学习过程中,把你认为有用的代码放在一起,积累更多,你可以在任何时候使用它。积木库中的信息越多,你在制作程序时的想法就越多

VBA的应用定义

VBA是利用office实现个人小型办公自动化的有效手段(工具)。这是我对VBA应用的定义。在取代office的新办公软件到来之前,谁能在数据处理方面取得最好成绩,谁就是王者。其中,VBA是最强大的技能

我记得20年前我第一次学习VBA时,材料很少。我只能看源代码,自己思考。这真的很难。20年后,为了不让我的朋友学习VBA重复我以前的经验,我在多年实践VBA的基础上开设了六门VBA特别课程经验:

第一套:VBA代码解决方案是解释VBA中的各种知识点。本教程共有147节课,涵盖了绝大多数VBA知识点,这是初学者所必需的

第二套:VBA数据库解决方案数据库是数据处理的专业工具,本教程详细介绍了用ADO连接accdb和excel的方法和示例操作,适合中级人员使用

第三套:VBA数组和字典解决方案数组和字典是VBA的精髓。字典是提高VBA代码水平的有效手段,值得深入学习。它是高级和中级人员代码的一种手段

第四套:VBA代码解决方案视频是针对初学者的视频讲解,可以快速入门,更快掌握这项技能。这套教程是第一套教程的视频讲解,更容易听元音

第五套:VBA中的课堂解读与运用。这是一门解释课堂虚无和肉体程度的高级课程。虽然课堂运用较少,但认真学习可以促进自身VBA理论的完善。对这套课程的理解主要是对f读者与一种佛教哲学

第六套教程:VBA信息获取与处理,这是一门高级课程,涵盖范围更广,对中高级人员更实用。该课程有20个主题,包括:跨应用程序信息获取、随机信息的利用、电子邮件发送、VBA Internet数据捕获、VBA delay操作、剪贴板应用程序、拆分功能扩展、工作表信息与其他应用程序的交互、FSO对象的使用、工作表和文件夹信息获取、图形信息获取和自定义工作表信息功能等

根据以上信息,您可以按照1的顺序逐步学习→ 3.→ 2.→ 6.→ 5或4→ 3.→ 2.→ 6.→ 5.本教程提供了说明和大量构建块。如果需要,您可以微信:nz9668

学习VBA是一个过程,也需要经历一种无聊的感觉

正如太白的诗所说:鸟儿高飞,寂寞的云朵独自消遣。你们不会厌倦彼此的相见,只有静亭山。学习的过程也是培养心灵的过程,培养一颗平静的心。在密码的世界里,当你的心灵平静时,你的身体自然会很好。当你平静时,你会很好没错。如果你心中没有那么多邪恶的知识和观点,你就不会有那么多妄想。对别人有益是自利。这些教程也是帮助你启航和帮助我的。我上面的教程是我的经验的传递

“水对万物都有好处,没有争议"学习也是一样。你知道你需要什么。不要蜷缩在一个你认为是天堂的小世界里。不要欺骗自己和他人,直到你年老。努力提高自己,用充满活力的心和精神把握现在。这是进步。事情越有意义,困难就越多。愿意做决定n智慧决定成败。无论你遇到什么,它都是一道风景。忽视争端,轻视得失。不管茶是满的还是小的,浓的还是淡的,它都有自己的味道值得品尝。去f

excelvba抓取网页数据(获取网页数据链接、识别汉字编码、转换和处理字符串并得到所需要的简单方法)

网站优化 • 优采云 发表了文章 • 0 个评论 • 478 次浏览 • 2021-09-11 13:12

第 1 课总结:

本课通过实例讲解获取网页数据链接、识别汉字编码、转换处理字符串、获取所需数据的简单方法。请课后找一些网站duoduo的测试,练习抓包软件的使用和获取字符串后拆分等功能提取数据的基本技巧。

在实际的网页采集中,我们经常会遇到比例子网站复杂几倍甚至几十倍的网页。一个完整的网页采集程序需要处理以下问题:

1、 如有必要,请登录网站。可能需要验证码(需要拿到图片做OCR识别)

2、找到网站的初始链接,获取cookie或viewstate等隐藏提交信息,准备提交真实数据链接。

3、如有需要可以找网站中文语言的设置方法,可以直接写在链接里,也可以写在提交的参数里,也可以提交专门的语言设置链接。

4、找到网站的数据链路,抓包获取Referer值,解决反盗链

5、处理初始网页,获取后续数据链接提交所需的参数(可能没有,也可能有很多)

6、Process 网站data 链接的提交参数(可能有时间戳),可能是GET或POST。后者还要处理URLEncode编码或者其他形式的编码(如果是UTF-8编码,XMLHTTP会自己处理;WinHttp可以通过参数选择URL编码格式)。

7、Judge 网站返回数据的编码处理成可识别的字符串(可能需要htmlfile对象快速操作html文档中的表格等)

8、处理需要采集数据的字符串,可能需要从中提取页码,可能需要提取下一页的参数,可能需要使用数组提取需要的信息(尤其是网络表单)

9、 循环执行 6~8 直到数据提取结束

其实无论网站多么复杂,获取数据的基础无非是两点:

1、抓包查看链接、Cookie、Referer、Post参数、隐藏提交参数、MD5或RSA加密参数等,然后模拟提交

2、处理编码和提取字符串

只要熟练掌握这两个基本步骤,再加上充足的时间、坚定的信念、耐心和一点点运气,采集网站的工作就迎刃而解!

相信我

附上一些VBA调用JS函数的方法。 查看全部

excelvba抓取网页数据(获取网页数据链接、识别汉字编码、转换和处理字符串并得到所需要的简单方法)

第 1 课总结:

本课通过实例讲解获取网页数据链接、识别汉字编码、转换处理字符串、获取所需数据的简单方法。请课后找一些网站duoduo的测试,练习抓包软件的使用和获取字符串后拆分等功能提取数据的基本技巧。

在实际的网页采集中,我们经常会遇到比例子网站复杂几倍甚至几十倍的网页。一个完整的网页采集程序需要处理以下问题:

1、 如有必要,请登录网站。可能需要验证码(需要拿到图片做OCR识别)

2、找到网站的初始链接,获取cookie或viewstate等隐藏提交信息,准备提交真实数据链接。

3、如有需要可以找网站中文语言的设置方法,可以直接写在链接里,也可以写在提交的参数里,也可以提交专门的语言设置链接。

4、找到网站的数据链路,抓包获取Referer值,解决反盗链

5、处理初始网页,获取后续数据链接提交所需的参数(可能没有,也可能有很多)

6、Process 网站data 链接的提交参数(可能有时间戳),可能是GET或POST。后者还要处理URLEncode编码或者其他形式的编码(如果是UTF-8编码,XMLHTTP会自己处理;WinHttp可以通过参数选择URL编码格式)。

7、Judge 网站返回数据的编码处理成可识别的字符串(可能需要htmlfile对象快速操作html文档中的表格等)

8、处理需要采集数据的字符串,可能需要从中提取页码,可能需要提取下一页的参数,可能需要使用数组提取需要的信息(尤其是网络表单)

9、 循环执行 6~8 直到数据提取结束

其实无论网站多么复杂,获取数据的基础无非是两点:

1、抓包查看链接、Cookie、Referer、Post参数、隐藏提交参数、MD5或RSA加密参数等,然后模拟提交

2、处理编码和提取字符串

只要熟练掌握这两个基本步骤,再加上充足的时间、坚定的信念、耐心和一点点运气,采集网站的工作就迎刃而解!

相信我

附上一些VBA调用JS函数的方法。

excelvba抓取网页数据( 关键词:excelvba股票,vbavba获取股票历史数据,获取)

网站优化 • 优采云 发表了文章 • 0 个评论 • 193 次浏览 • 2021-09-11 02:11

关键词:excelvba股票,vbavba获取股票历史数据,获取)

使用EXCEL VBA获取股票历史交易明细等高频数据

关键词:excel vba股票,vba获取历史股票数据,excel vba抓取网站data

这个东西是原创。原理是使用VBA从网页中获取数据,但不需要打开网页。

VBA在后台打开虚拟网页,分析抓取数据,速度相当快。我的网速一般,从一个网页中获取数据只需要大约 1 秒。

本程序可以实现以下功能:

1、导入任何一只股票自上市以来的开盘价、收盘价、最高价、最低价、成交量等数据;

2、 导入任意交易日任意股票的交易明细。包括交易时间、交易价格、交易量、交易金额等,对于一些需要高频数据的同学来说,这个东西很实用。本程序稍作修改,增加一个循环甚至导出所有股票的所有历史交易明细。有需要的同学可以找我。

3、导入新股会议数据,包括公司名称、申请时间、会议时间、当前状态等信息。

一般网页上的数据可以用VBA抓取,应用不错,可以实现大量数据的动态监控。

如果需要获取其他数据,可以私信给我。

这么好的东西不应该沉没,所以有钱就回复下载吧;如果你没有钱,回复我并寄给你。

补充内容(2014-3-22 14:21):

补充几个问题:

1、很多人找我要文件,我尽力了,可惜不能一一发。

2、 有人问我要源码,抱歉不能一一解答,也不好贴在这里。

3、如果你问我如何学习VBA,最好找这本教材有点基础知识。

使用EXCEL VBA获取股票历史交易明细等高频数据。抓取网页数据链接:密码:j33p

转载请注明:数据分析»使用EXCEL VBA获取股票历史交易明细等高频数据 查看全部

excelvba抓取网页数据(

关键词:excelvba股票,vbavba获取股票历史数据,获取)

使用EXCEL VBA获取股票历史交易明细等高频数据

关键词:excel vba股票,vba获取历史股票数据,excel vba抓取网站data

这个东西是原创。原理是使用VBA从网页中获取数据,但不需要打开网页。

VBA在后台打开虚拟网页,分析抓取数据,速度相当快。我的网速一般,从一个网页中获取数据只需要大约 1 秒。

本程序可以实现以下功能:

1、导入任何一只股票自上市以来的开盘价、收盘价、最高价、最低价、成交量等数据;

2、 导入任意交易日任意股票的交易明细。包括交易时间、交易价格、交易量、交易金额等,对于一些需要高频数据的同学来说,这个东西很实用。本程序稍作修改,增加一个循环甚至导出所有股票的所有历史交易明细。有需要的同学可以找我。

3、导入新股会议数据,包括公司名称、申请时间、会议时间、当前状态等信息。

一般网页上的数据可以用VBA抓取,应用不错,可以实现大量数据的动态监控。

如果需要获取其他数据,可以私信给我。

这么好的东西不应该沉没,所以有钱就回复下载吧;如果你没有钱,回复我并寄给你。

补充内容(2014-3-22 14:21):

补充几个问题:

1、很多人找我要文件,我尽力了,可惜不能一一发。

2、 有人问我要源码,抱歉不能一一解答,也不好贴在这里。

3、如果你问我如何学习VBA,最好找这本教材有点基础知识。

使用EXCEL VBA获取股票历史交易明细等高频数据。抓取网页数据链接:密码:j33p

转载请注明:数据分析»使用EXCEL VBA获取股票历史交易明细等高频数据