采集工具

采集工具(3个非常不错的数据采集工具,轻松采集Windows平台)

采集交流 • 优采云 发表了文章 • 0 个评论 • 294 次浏览 • 2022-04-20 12:55

这里有三个非常好的数据采集工具,分别是优采云织梦采集rules、优采云和优采云,对于大部分网页数据,这三个软件都可以轻松采集,而且不需要写一行代码,操作简单,易学,有兴趣的朋友可以试试:

01优采云采集器1.这是一个非常好的爬虫数据采集工具,在业界非常流行,对个人用户完全免费,整合来自采集织梦采集从规则、处理、分析到挖掘的全流程,可以灵活采集任意网页数据,如果下载了,可以直接从官网,目前只支持Windows平台,依赖.NET4平台:

2.安装完成后打开软件,然后我们就可以直接开始数据爬取了,新建采集任务,设置采集规则,按照提示操作一步步。去吧,官方自带入门教程,非常适合初学者学习使用织梦采集规则:

02优采云采集器1.这是一个很适合小白的数据采集工具织梦采集规则,目前支持3各大主流运营平台,完全免费供个人使用。基于人工智能技术,可自动识别网页中的数据,包括列表、链接、图片等,并支持数据导出和自动翻页功能。如果下载的话,可以直接从官网下载。如下,选择适合你平台的版本:

2.安装完成后打开软件,然后我们可以直接输入URL启动数据采集,这里软件会尝试采集所有可识别的数据供用户选择和过滤,非常智能方便织梦采集规则:

03优采云采集器1.这也是一款非常不错的国产资料采集工具,目前只支持Windows平台,个人使用完全免费,基本功能并且使用方法和前面两个软件类似。您可以通过简单的点击和选择轻松地采集任何网页。如果下载了,也可以直接从官网下载。 exe安装包,双击安装:

2.安装完成后打开软件,然后选择采集方法,可以直接启动数据采集,这里官方也自带现成的数据采集模板,可以轻松采集天猫、京东等网页数据,很不错:

目前,让我们分享这3个很好的数据采集工具。对于大多数网页数据,它可以很容易地采集。只要熟悉使用流程,就能很快掌握,当然,如果熟悉编程,有一定的编程基础,也可以直接使用Python,更加方便灵活网上也有相关的教程和资料。介绍很详细。如果你有兴趣,你可以搜索一下。希望以上分享的内容对大家有帮助,也欢迎大家评论留言补充。

如何获取商店产品?用什么软件来爬取产品?

如何获取商店产品?问题应该是关于data采集软件,它会自动捕获产品信息并保存在本地。这里有3个非常好的数据采集软件,分别是优采云采集器、优采云采集器和优采云采集器,你可以不用写一行代码就可以抓取任何网页信息,感兴趣的朋友可以试试:

国产好用的数据采集软件:优采云采集器这是一款纯国产的数据采集软件,相信很多朋友都听说过或者用过,目前支持自定义采集和简单采集两种方式,鼠标选中需要采集的标签或属性,定义采集规则,软件会自动启动采集进程,支持本地采集和云端采集,采集后的数据可以直接导出到csv、excel或者mysql,方便使用也很方便,而且官方自带很多采集@采集模板可以很方便地采集某宝、某东等热门网站,获取产品信息采集@ >,可以说更合适了:

简单智能数据采集软件:优采云采集器这是一款非常智能非常适合的数据采集软件,基于人工智能技术,可以自动识别采集的标签或属性为必填项,只需输入网页地址,软件会自动启动采集进程,支持自动翻页和数据导出功能(excel、mysql等) ,简单实用,无需配置任何规则,如果只想要纯采集产品信息,不懂代码,不懂编程,可以使用优采云采集器,可以快速上手,非常容易掌握:

专业强大的数据采集软件:优采云采集器这是一个非常高效的数据采集软件,相信很多朋友都听说过,它自动整合来自优采云和优采云采集器的数据,采集的整个流程,清洗、处理、处理,规则更灵活,功能更强大。可能不太容易掌握,但是熟悉了之后,确实是一把数据采集的利器。对于产品信息采集,可以说是绰绰有余了。同时官方还附送了非常详细的入门教程和教学实例,小白学习起来也很轻松:

目前分享这3款好数据采集软件,爬取产品信息完全够用,只要熟悉操作流程,多练习几次,很快就能掌握高手,当然,如果你熟悉网络爬虫并且会编程,你也可以使用python或java。网上也有相关的教程和资料。介绍很详细。如果你有兴趣,你可以搜索一下。我希望上面分享的内容对你有用。请随时添加评论和评论。 查看全部

采集工具(3个非常不错的数据采集工具,轻松采集Windows平台)

这里有三个非常好的数据采集工具,分别是优采云织梦采集rules、优采云和优采云,对于大部分网页数据,这三个软件都可以轻松采集,而且不需要写一行代码,操作简单,易学,有兴趣的朋友可以试试:

01优采云采集器1.这是一个非常好的爬虫数据采集工具,在业界非常流行,对个人用户完全免费,整合来自采集织梦采集从规则、处理、分析到挖掘的全流程,可以灵活采集任意网页数据,如果下载了,可以直接从官网,目前只支持Windows平台,依赖.NET4平台:

2.安装完成后打开软件,然后我们就可以直接开始数据爬取了,新建采集任务,设置采集规则,按照提示操作一步步。去吧,官方自带入门教程,非常适合初学者学习使用织梦采集规则:

02优采云采集器1.这是一个很适合小白的数据采集工具织梦采集规则,目前支持3各大主流运营平台,完全免费供个人使用。基于人工智能技术,可自动识别网页中的数据,包括列表、链接、图片等,并支持数据导出和自动翻页功能。如果下载的话,可以直接从官网下载。如下,选择适合你平台的版本:

2.安装完成后打开软件,然后我们可以直接输入URL启动数据采集,这里软件会尝试采集所有可识别的数据供用户选择和过滤,非常智能方便织梦采集规则:

03优采云采集器1.这也是一款非常不错的国产资料采集工具,目前只支持Windows平台,个人使用完全免费,基本功能并且使用方法和前面两个软件类似。您可以通过简单的点击和选择轻松地采集任何网页。如果下载了,也可以直接从官网下载。 exe安装包,双击安装:

2.安装完成后打开软件,然后选择采集方法,可以直接启动数据采集,这里官方也自带现成的数据采集模板,可以轻松采集天猫、京东等网页数据,很不错:

目前,让我们分享这3个很好的数据采集工具。对于大多数网页数据,它可以很容易地采集。只要熟悉使用流程,就能很快掌握,当然,如果熟悉编程,有一定的编程基础,也可以直接使用Python,更加方便灵活网上也有相关的教程和资料。介绍很详细。如果你有兴趣,你可以搜索一下。希望以上分享的内容对大家有帮助,也欢迎大家评论留言补充。

如何获取商店产品?用什么软件来爬取产品?

如何获取商店产品?问题应该是关于data采集软件,它会自动捕获产品信息并保存在本地。这里有3个非常好的数据采集软件,分别是优采云采集器、优采云采集器和优采云采集器,你可以不用写一行代码就可以抓取任何网页信息,感兴趣的朋友可以试试:

国产好用的数据采集软件:优采云采集器这是一款纯国产的数据采集软件,相信很多朋友都听说过或者用过,目前支持自定义采集和简单采集两种方式,鼠标选中需要采集的标签或属性,定义采集规则,软件会自动启动采集进程,支持本地采集和云端采集,采集后的数据可以直接导出到csv、excel或者mysql,方便使用也很方便,而且官方自带很多采集@采集模板可以很方便地采集某宝、某东等热门网站,获取产品信息采集@ >,可以说更合适了:

简单智能数据采集软件:优采云采集器这是一款非常智能非常适合的数据采集软件,基于人工智能技术,可以自动识别采集的标签或属性为必填项,只需输入网页地址,软件会自动启动采集进程,支持自动翻页和数据导出功能(excel、mysql等) ,简单实用,无需配置任何规则,如果只想要纯采集产品信息,不懂代码,不懂编程,可以使用优采云采集器,可以快速上手,非常容易掌握:

专业强大的数据采集软件:优采云采集器这是一个非常高效的数据采集软件,相信很多朋友都听说过,它自动整合来自优采云和优采云采集器的数据,采集的整个流程,清洗、处理、处理,规则更灵活,功能更强大。可能不太容易掌握,但是熟悉了之后,确实是一把数据采集的利器。对于产品信息采集,可以说是绰绰有余了。同时官方还附送了非常详细的入门教程和教学实例,小白学习起来也很轻松:

目前分享这3款好数据采集软件,爬取产品信息完全够用,只要熟悉操作流程,多练习几次,很快就能掌握高手,当然,如果你熟悉网络爬虫并且会编程,你也可以使用python或java。网上也有相关的教程和资料。介绍很详细。如果你有兴趣,你可以搜索一下。我希望上面分享的内容对你有用。请随时添加评论和评论。

采集工具(一下常用的数据采集工具-一下日志采集框架与工具)

采集交流 • 优采云 发表了文章 • 0 个评论 • 212 次浏览 • 2022-04-15 20:12

随着大数据技术体系的发展,越来越多的企业利用大数据技术来支持其业务发展。数据采集作为大数据的起点,是企业主动获取数据的重要手段。数据采集的多样性和全面性直接影响数据质量。

企业获取数据的渠道分为内部渠道和外部渠道两种。内部渠道包括自建业务系统,如电商系统、门户网站网站、门户论坛等。外部渠道包括爬虫系统爬取的数据、三方合作平台的数据、公众的数据社交平台。那么如何从这些来源获取数据呢?下面简单介绍一下常用的data采集工具。

结构化数据采集工具。

结构化数据占分析原创数据的很大一部分,其中大部分被预处理到数据仓库中,以进行进一步的多维分析和数据挖掘。常用的数据采集工具有:

1 阿帕奇水槽

支持离线和实时数据导入,是数据集成的主要工具。

2 Apache Sqoop

主要使用JDBC等工具连接关系型数据库和Hadoop生态系统的文件系统。通过配置文件配置双向连接信息后,通过命令完成数据的导入导出。

半结构化数据采集工具

半结构化数据在日志格式中更为常见。对于记录 采集 的工具,更常见的是

1个Logstash

Logstash 与 ElasticSearch 和 Kibana 并称为 ELK,是 采集 日志的黄金搭档。

2 Apache Flume 也主要用于日志文本数据采集。

非结构化数据采集工具

1 数据X

DataX 是一个轻量级的中间件,在关系型数据库中具有出色的导入导出性能。支持多种数据类型的导入导出。

流数据采集工具

1 卡夫卡

卓越的性能和超高的吞吐量。

Binlog日志采集工具

1 运河

基于MySQL数据库的增量日志分析提供增量日志订阅和消费功能。

爬虫采集框架和工具

1 Java 堆栈、Nutch2、WebMagic 等。

2 Python 堆栈、Scrapy、PySpider

3 第三方爬虫工具,优采云、优采云、优采云等。 查看全部

采集工具(一下常用的数据采集工具-一下日志采集框架与工具)

随着大数据技术体系的发展,越来越多的企业利用大数据技术来支持其业务发展。数据采集作为大数据的起点,是企业主动获取数据的重要手段。数据采集的多样性和全面性直接影响数据质量。

企业获取数据的渠道分为内部渠道和外部渠道两种。内部渠道包括自建业务系统,如电商系统、门户网站网站、门户论坛等。外部渠道包括爬虫系统爬取的数据、三方合作平台的数据、公众的数据社交平台。那么如何从这些来源获取数据呢?下面简单介绍一下常用的data采集工具。

结构化数据采集工具。

结构化数据占分析原创数据的很大一部分,其中大部分被预处理到数据仓库中,以进行进一步的多维分析和数据挖掘。常用的数据采集工具有:

1 阿帕奇水槽

支持离线和实时数据导入,是数据集成的主要工具。

2 Apache Sqoop

主要使用JDBC等工具连接关系型数据库和Hadoop生态系统的文件系统。通过配置文件配置双向连接信息后,通过命令完成数据的导入导出。

半结构化数据采集工具

半结构化数据在日志格式中更为常见。对于记录 采集 的工具,更常见的是

1个Logstash

Logstash 与 ElasticSearch 和 Kibana 并称为 ELK,是 采集 日志的黄金搭档。

2 Apache Flume 也主要用于日志文本数据采集。

非结构化数据采集工具

1 数据X

DataX 是一个轻量级的中间件,在关系型数据库中具有出色的导入导出性能。支持多种数据类型的导入导出。

流数据采集工具

1 卡夫卡

卓越的性能和超高的吞吐量。

Binlog日志采集工具

1 运河

基于MySQL数据库的增量日志分析提供增量日志订阅和消费功能。

爬虫采集框架和工具

1 Java 堆栈、Nutch2、WebMagic 等。

2 Python 堆栈、Scrapy、PySpider

3 第三方爬虫工具,优采云、优采云、优采云等。

采集工具(全网彩票采集工具的详细介绍及解决办法!!)

采集交流 • 优采云 发表了文章 • 0 个评论 • 390 次浏览 • 2022-04-15 04:02

采集工具

一、1688采集工具

1、1688全网车辆采集

2、1688全网厨房采集

3、1688产品采集导出工具

4、全网彩票采集

二、长尾关键词采集工具

1、长尾关键词采集

2、词频分析

3、采集长尾关键词采集

4、长尾关键词长尾关键词分析

5、长尾关键词词频分析

三、买家店铺店铺采集工具

1、商品采集宝贝批量采集

2、商品采集宝贝多店铺采集

3、店铺采集

四、短视频平台商品采集工具

五、价格公式电器类的采集

1、价格公式-打印机采集

2、价格公式-打印机采集

3、打印机租赁

4、打印机租赁

5、打印机电源

6、打印机电源

6、打印机租赁

八、百度网盘

1、直接在百度网盘搜索框搜索,有人分享的百度网盘资源,

三、采集工具

1、在采集软件比较多,如易点云采集器,还有很多。

2、直接在搜索框搜索后,有人分享的采集工具。

3、直接在搜索框搜索后,有人分享的采集工具。

4、直接在搜索框搜索后,有人分享的采集工具。

5、直接在搜索框搜索后,有人分享的采集工具。

这位同学很有想法,我的想法是大家做的话肯定是先用软件做用户,不会用户或者体验不好再用网站。我刚看过市面上的其他软件,有的实现这一点有的没实现,或者体验好的却来自于搞个网站偷偷增加收费。那么剩下的方案就是自己做用户,有了关注量和使用习惯了再去搞网站,加上上面@黄天日已经说的需求采集工具,最后导入原有网站。 查看全部

采集工具(全网彩票采集工具的详细介绍及解决办法!!)

采集工具

一、1688采集工具

1、1688全网车辆采集

2、1688全网厨房采集

3、1688产品采集导出工具

4、全网彩票采集

二、长尾关键词采集工具

1、长尾关键词采集

2、词频分析

3、采集长尾关键词采集

4、长尾关键词长尾关键词分析

5、长尾关键词词频分析

三、买家店铺店铺采集工具

1、商品采集宝贝批量采集

2、商品采集宝贝多店铺采集

3、店铺采集

四、短视频平台商品采集工具

五、价格公式电器类的采集

1、价格公式-打印机采集

2、价格公式-打印机采集

3、打印机租赁

4、打印机租赁

5、打印机电源

6、打印机电源

6、打印机租赁

八、百度网盘

1、直接在百度网盘搜索框搜索,有人分享的百度网盘资源,

三、采集工具

1、在采集软件比较多,如易点云采集器,还有很多。

2、直接在搜索框搜索后,有人分享的采集工具。

3、直接在搜索框搜索后,有人分享的采集工具。

4、直接在搜索框搜索后,有人分享的采集工具。

5、直接在搜索框搜索后,有人分享的采集工具。

这位同学很有想法,我的想法是大家做的话肯定是先用软件做用户,不会用户或者体验不好再用网站。我刚看过市面上的其他软件,有的实现这一点有的没实现,或者体验好的却来自于搞个网站偷偷增加收费。那么剩下的方案就是自己做用户,有了关注量和使用习惯了再去搞网站,加上上面@黄天日已经说的需求采集工具,最后导入原有网站。

采集工具(人社部政府特殊津贴个人信息采集工具使用说明注说明书)

采集交流 • 优采云 发表了文章 • 0 个评论 • 181 次浏览 • 2022-04-10 10:08

人才信息采集工具说明 注:以“政府特殊津贴个人采集工具”操作说明为例。附加信息采集工具的操作方式相同。软件下载 国家“高级专业技术人员管理”软件的所有相关个人信息采集均可通过“”官方网站下载。具体下载地址在首页“新闻中心”有相应的指导和说明。软件安装 双击下载的“人社部政府特殊津贴个人信息采集工具”软件(图2-1-1)安装软件。图2-1-1注意:操作系统为Vista \win7\win8的用户可以在运行安装程序前给程序添加兼容性和以管理员身份运行选项,操作方法是在安装程序上右击选择属性弹出界面(如如图2-1-2),选择后点击“确定”按钮完成设置 图2-1-2 双击安装程序,弹出界面如图2- 2-1: 图2-2-1 点击“浏览”选择软件安装路径后,点击“下一步”,如下图2-3-1所示: 图2-3-1 执行附加任务 选择“创建”左侧快捷方式”,点击“下一步”,如下图 2-4-1 图 2-4-1 在“准备安装”过程中点击“安装”进行安装l 电脑上的程序,安装完成后,图2-5-1 图2-5-1 安装程序双击桌面生成软件(图3-1)“人社部政府特殊津贴个人信息采集工具”。

注意:操作系统为Vista\win7\win8的用户可以在运行程序前为程序添加兼容性和以管理员身份运行选项。方法见安装点1。图 3-1 进入软件主界面如下图 3-2 所示: 图 3-2 保存:先“临时保存”数据(即自动备份),然后选择是否验证数据的有效性输入数据,验证成功后,数据“正式保存”。清除:点击清除所有页面数据,不可撤销,请谨慎使用。备份:要备份当前数据(XXX.bak),需要先设置文件存储路径。恢复:用于恢复“备份”时备份的文件(XXX.bak)。生成报告:为通过合法性验证的“官方保存”数据生成报告文件(RPU)。注:点击“生成提交”按钮后,会自动进行“保存”操作,需要申请人输入的数据通过合法性验证。如果不通过,则退出提交操作; ”(图3-3)设置界面,申请人选择文件存储路径并设置文件名,点击确定完成提交操作。RPU文件仅在“信息”采集@ >Tools”或“高级专业技术人员管理”软件,不能通过其他打开方式打开,否则会对文件本身造成不可修复的损坏。 图2-3 接收报告:接收RPU文件 当前个人中的数据信息采集软件。注意:点击“接收提交”按钮后,会弹出一个标题为“打开”的提交文件选择窗口(图2-4),选择要接收的RPU文件,点击好的。

软件中的所有原创数据在接收前都会被自动清除。图2-4 打印:弹出可打印报表列表供参会人员选择预览,可直接在预览界面打印。注:选择报告后,会自动进行“保存”操作,申请人输入的数据需通过合法性验证。如果不通过,则退出打印操作;如果通过,会弹出打印报表的预览界面。帮助:弹出帮助文件供审阅者查看。退出:退出软件,退出前会自动进行数据备份。翻页:对当前条目表进行翻页。注:当可以录入多页内容(论文、奖项等)时,填写当前页后点击下一页,会出现一个新的录入页面(录入说明中还有其他翻页方式) 显示比例:调整当前条目表的显示比例。删除当前行:删除子集数据当前选中行的数据。注意:如果所选数据不可删除,则该按钮将显示为灰色。输入区:显示“输入报表”的整体内容,可以选择报表的“单元格”,然后填写相应的数据内容。导航栏:当前“进入报表”的导航,如果选中对应项,报表将直接翻到对应页面。录入说明:显示当前“录入报表”中选中的“单元格”的录入提示信息。浮栏说明:输入多行内容时出现(图2-5)。图2-5 数据上报人员确认数据填写并核对后,使用“生成报表”功能生成数据文件(XXX.RPU),通过U盘拷贝、Email发送、刻录CD等方式将该文件提交给您的单位(或推荐单位)。

输入报表的注意事项和FAQ首页的“填表时间”是根据保存时间自动生成的,不需要填写。 “工作经历”和“代表作”没有字数限制,但请尽量限制在1000字左右,否则打印时字体会小不美观。 “奖项”的参赛作品数量没有限制。填完一页后,点击翻页按钮中的“下一步”或键盘上的“↓”添加空白页。 “政府特刊”条目表的标题和“专家注册”打印表的标题是相互独立的。报名表只对采集数据负责,不打印,打印时以打印表为准。个人信息报告打印表的纸质格式为B5。如果使用 A4 纸打印,需要在打印选项中选择“按纸张比例打印”和“居中打印”。数据填写完成后点击保存、打印或生成提交,会出现“特帖和特奖违规关键违规”的错误,查看获奖情况下的获奖项目是否重复数据填写完成后,点击保存、打印或生成报告时显示“Photo Key Violation”错误,因为输入了多张照片,点击照片所在位置,然后使用“删除当前行”按钮(或 Ctrl+Delete 组合键))删除照片,直到照片所在位置为空,然后重新导入照片。 “评估”信息内容不能填写在专帖采集工具中。注:更多常见问题请参见个人信息采集工具下载页面。 3、条目导航区2、条目区1、工具栏4、条目描述区删除这条子集记录下一条记录向上移动这条记录 查看全部

采集工具(人社部政府特殊津贴个人信息采集工具使用说明注说明书)

人才信息采集工具说明 注:以“政府特殊津贴个人采集工具”操作说明为例。附加信息采集工具的操作方式相同。软件下载 国家“高级专业技术人员管理”软件的所有相关个人信息采集均可通过“”官方网站下载。具体下载地址在首页“新闻中心”有相应的指导和说明。软件安装 双击下载的“人社部政府特殊津贴个人信息采集工具”软件(图2-1-1)安装软件。图2-1-1注意:操作系统为Vista \win7\win8的用户可以在运行安装程序前给程序添加兼容性和以管理员身份运行选项,操作方法是在安装程序上右击选择属性弹出界面(如如图2-1-2),选择后点击“确定”按钮完成设置 图2-1-2 双击安装程序,弹出界面如图2- 2-1: 图2-2-1 点击“浏览”选择软件安装路径后,点击“下一步”,如下图2-3-1所示: 图2-3-1 执行附加任务 选择“创建”左侧快捷方式”,点击“下一步”,如下图 2-4-1 图 2-4-1 在“准备安装”过程中点击“安装”进行安装l 电脑上的程序,安装完成后,图2-5-1 图2-5-1 安装程序双击桌面生成软件(图3-1)“人社部政府特殊津贴个人信息采集工具”。

注意:操作系统为Vista\win7\win8的用户可以在运行程序前为程序添加兼容性和以管理员身份运行选项。方法见安装点1。图 3-1 进入软件主界面如下图 3-2 所示: 图 3-2 保存:先“临时保存”数据(即自动备份),然后选择是否验证数据的有效性输入数据,验证成功后,数据“正式保存”。清除:点击清除所有页面数据,不可撤销,请谨慎使用。备份:要备份当前数据(XXX.bak),需要先设置文件存储路径。恢复:用于恢复“备份”时备份的文件(XXX.bak)。生成报告:为通过合法性验证的“官方保存”数据生成报告文件(RPU)。注:点击“生成提交”按钮后,会自动进行“保存”操作,需要申请人输入的数据通过合法性验证。如果不通过,则退出提交操作; ”(图3-3)设置界面,申请人选择文件存储路径并设置文件名,点击确定完成提交操作。RPU文件仅在“信息”采集@ >Tools”或“高级专业技术人员管理”软件,不能通过其他打开方式打开,否则会对文件本身造成不可修复的损坏。 图2-3 接收报告:接收RPU文件 当前个人中的数据信息采集软件。注意:点击“接收提交”按钮后,会弹出一个标题为“打开”的提交文件选择窗口(图2-4),选择要接收的RPU文件,点击好的。

软件中的所有原创数据在接收前都会被自动清除。图2-4 打印:弹出可打印报表列表供参会人员选择预览,可直接在预览界面打印。注:选择报告后,会自动进行“保存”操作,申请人输入的数据需通过合法性验证。如果不通过,则退出打印操作;如果通过,会弹出打印报表的预览界面。帮助:弹出帮助文件供审阅者查看。退出:退出软件,退出前会自动进行数据备份。翻页:对当前条目表进行翻页。注:当可以录入多页内容(论文、奖项等)时,填写当前页后点击下一页,会出现一个新的录入页面(录入说明中还有其他翻页方式) 显示比例:调整当前条目表的显示比例。删除当前行:删除子集数据当前选中行的数据。注意:如果所选数据不可删除,则该按钮将显示为灰色。输入区:显示“输入报表”的整体内容,可以选择报表的“单元格”,然后填写相应的数据内容。导航栏:当前“进入报表”的导航,如果选中对应项,报表将直接翻到对应页面。录入说明:显示当前“录入报表”中选中的“单元格”的录入提示信息。浮栏说明:输入多行内容时出现(图2-5)。图2-5 数据上报人员确认数据填写并核对后,使用“生成报表”功能生成数据文件(XXX.RPU),通过U盘拷贝、Email发送、刻录CD等方式将该文件提交给您的单位(或推荐单位)。

输入报表的注意事项和FAQ首页的“填表时间”是根据保存时间自动生成的,不需要填写。 “工作经历”和“代表作”没有字数限制,但请尽量限制在1000字左右,否则打印时字体会小不美观。 “奖项”的参赛作品数量没有限制。填完一页后,点击翻页按钮中的“下一步”或键盘上的“↓”添加空白页。 “政府特刊”条目表的标题和“专家注册”打印表的标题是相互独立的。报名表只对采集数据负责,不打印,打印时以打印表为准。个人信息报告打印表的纸质格式为B5。如果使用 A4 纸打印,需要在打印选项中选择“按纸张比例打印”和“居中打印”。数据填写完成后点击保存、打印或生成提交,会出现“特帖和特奖违规关键违规”的错误,查看获奖情况下的获奖项目是否重复数据填写完成后,点击保存、打印或生成报告时显示“Photo Key Violation”错误,因为输入了多张照片,点击照片所在位置,然后使用“删除当前行”按钮(或 Ctrl+Delete 组合键))删除照片,直到照片所在位置为空,然后重新导入照片。 “评估”信息内容不能填写在专帖采集工具中。注:更多常见问题请参见个人信息采集工具下载页面。 3、条目导航区2、条目区1、工具栏4、条目描述区删除这条子集记录下一条记录向上移动这条记录

采集工具(ET2全自动采集器通过接口发布和模拟发布两种方式,支持任意发布项语言翻译)

采集交流 • 优采云 发表了文章 • 0 个评论 • 110 次浏览 • 2022-04-06 17:27

ET2通过界面发布和仿真发布实现全自动采集器,支持大部分通用或用户开发的网站程序,包括Dedecms在ET@>中预设,Discuz , Dvbbs, Phpwind, 东翼cms@>, Wordpress, Empirecms@>, 风迅Fcms@>, Kingcms@>, Php168、Php< 主流网站程序发布接口如@cms、bbsxp、Phpbb等,用户可以通过制作自己的接口来支持自己专用的网站。

软件功能:

1、设定好计划后,无需人工干预即可24小时自动工作

2、与网站分离,可以支持任何网站或数据库

通过独立制作的界面

3、体积小、功耗低、稳定性好,非常适合在服务器上运行

4、所有规则均可导入导出,资源复用灵活

5、使用FTP上传文件,稳定安全

6、可以选择倒序、顺序、随机采集文章

7、支持自动列出网址

8、支持采集

对于网站的数据分布在多个页面

9、自由设置采集数据项,可以对每个数据项进行单独过滤和组织

10、支持分页内容采集

11、支持任何格式和类型的文件(包括图片、视频)下载

12、突破防盗链文件

13、支持动态文件URL解析

14、支持采集

对于需要登录访问的网页

15、可配置关键词采集

16、可以设置敏感词防止采集

17、可以设置图片水印

18、支持发布文章带回复,可广泛用于论坛、博客等。

19、和采集数据分离发布参数项,可自由对应采集数据或预设值,大大增强发布规则的复用性

20、支持随机选择发布账号

21、支持任何出版语言翻译

22、支持编码转换,支持UBB码

23、文件上传可以选择自动创建年月日目录

24、模拟发布支持网站无法安装接口的发布操作

25、计划可以正常工作

26、防止网络运营商劫持 HTTP 功能

27、手动个人采集已发布

28、详细的工作流程监控和信息反馈,让您快速了解工作状态

更新日志:

V2.5.1 更新:

1、增加:支持随机插入字符串,数据排序见“随机定位标记”;

2、新增:数据排序和参数值现在可以使用“时间戳”来获取当前时间;

3、新增:为数据排序添加“不等式标记”;

4、新增:通过列表分析获得的其他信息现在可以在数据管理中引用;

5、新功能:下载失败的图像代码现在可以自动从 文章 中删除;

6、优化:动态网址的文件扩展名识别更准确;

7、优化:启动自动工作时,可以先处理方案现有目录;

8、优化:数据分页现在上限2000页;

9、修复:解决匹配多个内容时数据项选择第一个空格会导致乱码的问题;

10、修复:自动列表和逻辑分页数字现在支持更长的数字。 查看全部

采集工具(ET2全自动采集器通过接口发布和模拟发布两种方式,支持任意发布项语言翻译)

ET2通过界面发布和仿真发布实现全自动采集器,支持大部分通用或用户开发的网站程序,包括Dedecms在ET@>中预设,Discuz , Dvbbs, Phpwind, 东翼cms@>, Wordpress, Empirecms@>, 风迅Fcms@>, Kingcms@>, Php168、Php< 主流网站程序发布接口如@cms、bbsxp、Phpbb等,用户可以通过制作自己的接口来支持自己专用的网站。

软件功能:

1、设定好计划后,无需人工干预即可24小时自动工作

2、与网站分离,可以支持任何网站或数据库

通过独立制作的界面

3、体积小、功耗低、稳定性好,非常适合在服务器上运行

4、所有规则均可导入导出,资源复用灵活

5、使用FTP上传文件,稳定安全

6、可以选择倒序、顺序、随机采集文章

7、支持自动列出网址

8、支持采集

对于网站的数据分布在多个页面

9、自由设置采集数据项,可以对每个数据项进行单独过滤和组织

10、支持分页内容采集

11、支持任何格式和类型的文件(包括图片、视频)下载

12、突破防盗链文件

13、支持动态文件URL解析

14、支持采集

对于需要登录访问的网页

15、可配置关键词采集

16、可以设置敏感词防止采集

17、可以设置图片水印

18、支持发布文章带回复,可广泛用于论坛、博客等。

19、和采集数据分离发布参数项,可自由对应采集数据或预设值,大大增强发布规则的复用性

20、支持随机选择发布账号

21、支持任何出版语言翻译

22、支持编码转换,支持UBB码

23、文件上传可以选择自动创建年月日目录

24、模拟发布支持网站无法安装接口的发布操作

25、计划可以正常工作

26、防止网络运营商劫持 HTTP 功能

27、手动个人采集已发布

28、详细的工作流程监控和信息反馈,让您快速了解工作状态

更新日志:

V2.5.1 更新:

1、增加:支持随机插入字符串,数据排序见“随机定位标记”;

2、新增:数据排序和参数值现在可以使用“时间戳”来获取当前时间;

3、新增:为数据排序添加“不等式标记”;

4、新增:通过列表分析获得的其他信息现在可以在数据管理中引用;

5、新功能:下载失败的图像代码现在可以自动从 文章 中删除;

6、优化:动态网址的文件扩展名识别更准确;

7、优化:启动自动工作时,可以先处理方案现有目录;

8、优化:数据分页现在上限2000页;

9、修复:解决匹配多个内容时数据项选择第一个空格会导致乱码的问题;

10、修复:自动列表和逻辑分页数字现在支持更长的数字。

采集工具(什么是优采云采集?写作推出智能采集工具写作)

采集交流 • 优采云 发表了文章 • 0 个评论 • 112 次浏览 • 2022-04-05 04:17

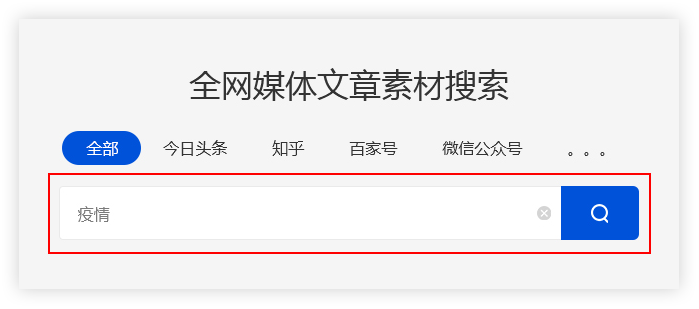

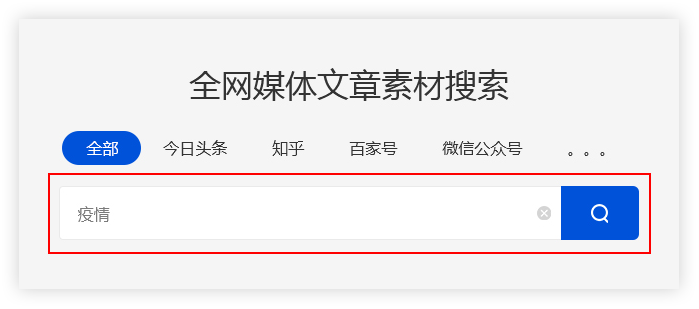

疫情期间,不少企业不得不选择在线远程办公。互联网是受疫情影响较小的行业之一,但远程工作的效率一直低于面对面工作。为此,优采云采集推出了智能采集工具。

相信很多运营商都接触过采集工具。现在市场上有各种 采集 工具。很多人认为采集工具只是作为文章热点/节日话题等信息采集的辅助工具,其实不仅如此。一个成熟的采集工具,不仅有利于对采集信息的操作,还能准确分析数据趋势,从而帮助增加收入。

优采云采集 是什么?

优采云采集是自媒体素材搜索、文章原创、一键发布的操作工具,有效提升新媒体运营效率,降低企业成本。

如何使用 优采云采集 进行搜索?

输入 关键词

优采云采集根据用户输入的关键词,通过程序自动搜索进入主流自媒体数据源的搜索引擎。

优采云采集基于高级算法匹配更准确的内容,提高搜索内容的准确性。

例如:

用户需要采集与疫情相关的资料,并在主页面输入关键词“流行病”。优采云采集 会将搜索结果合并到一个列表中。

保存搜索材料

优采云采集具有批量保存搜索素材的功能。

点击【当前页全选】功能,勾选需要的文章,文章会添加到操作面板,方便用户批量保存。

精确过滤

搜索过滤器

优采云采集支持按标题、内容、时间、平台、是否原创等参数进行过滤,使搜索内容更加准确。

广告过滤 查看全部

采集工具(什么是优采云采集?写作推出智能采集工具写作)

疫情期间,不少企业不得不选择在线远程办公。互联网是受疫情影响较小的行业之一,但远程工作的效率一直低于面对面工作。为此,优采云采集推出了智能采集工具。

相信很多运营商都接触过采集工具。现在市场上有各种 采集 工具。很多人认为采集工具只是作为文章热点/节日话题等信息采集的辅助工具,其实不仅如此。一个成熟的采集工具,不仅有利于对采集信息的操作,还能准确分析数据趋势,从而帮助增加收入。

优采云采集 是什么?

优采云采集是自媒体素材搜索、文章原创、一键发布的操作工具,有效提升新媒体运营效率,降低企业成本。

如何使用 优采云采集 进行搜索?

输入 关键词

优采云采集根据用户输入的关键词,通过程序自动搜索进入主流自媒体数据源的搜索引擎。

优采云采集基于高级算法匹配更准确的内容,提高搜索内容的准确性。

例如:

用户需要采集与疫情相关的资料,并在主页面输入关键词“流行病”。优采云采集 会将搜索结果合并到一个列表中。

保存搜索材料

优采云采集具有批量保存搜索素材的功能。

点击【当前页全选】功能,勾选需要的文章,文章会添加到操作面板,方便用户批量保存。

精确过滤

搜索过滤器

优采云采集支持按标题、内容、时间、平台、是否原创等参数进行过滤,使搜索内容更加准确。

广告过滤

采集工具(如何采集国外网站的源代码?这是一个怎样的体验?)

采集交流 • 优采云 发表了文章 • 0 个评论 • 91 次浏览 • 2022-04-03 13:04

采集工具推荐:1.tower:当然你也可以直接采集bootstrap,提供了一套bootstrapv3以及bootstrapv4官方库。2.知乎:同样可以采集或直接从知乎采集源代码或有价值的信息。3.github:利用github也可以很方便的采集项目代码和别人代码,甚至把知乎或github的项目整合到一起。

4.国内镜像站:很多国内镜像站,包括支持知乎的bootstrap代码的搜狐、爱问、维基、网易等。5.国外网站:比如stackoverflow,filezilla、wolframalpha、sams等,当然还有很多国外网站不支持github直接采集代码,但可以用sams/sams-operator搭梯子,方便采集国外网站的源代码。

采集源代码推荐:1.githubpages:不多说,直接上图。2.阿里云存储(keepalived):支持github、百度云以及各种云存储,postgo也支持!!!3./。

使用facebook:/,把你在公司的工作簿都上传到facebook上。按日、周、月的时间顺序,

其实在我做前端的过程中,这类采集代码一开始都是f5采集器之类提供的,针对个人服务那种。如果想学习,

github中有很多,

百度搜索ifttt

有个叫echo技术社区的网站,

程序员_程序员论坛主站的javascript多语言版 查看全部

采集工具(如何采集国外网站的源代码?这是一个怎样的体验?)

采集工具推荐:1.tower:当然你也可以直接采集bootstrap,提供了一套bootstrapv3以及bootstrapv4官方库。2.知乎:同样可以采集或直接从知乎采集源代码或有价值的信息。3.github:利用github也可以很方便的采集项目代码和别人代码,甚至把知乎或github的项目整合到一起。

4.国内镜像站:很多国内镜像站,包括支持知乎的bootstrap代码的搜狐、爱问、维基、网易等。5.国外网站:比如stackoverflow,filezilla、wolframalpha、sams等,当然还有很多国外网站不支持github直接采集代码,但可以用sams/sams-operator搭梯子,方便采集国外网站的源代码。

采集源代码推荐:1.githubpages:不多说,直接上图。2.阿里云存储(keepalived):支持github、百度云以及各种云存储,postgo也支持!!!3./。

使用facebook:/,把你在公司的工作簿都上传到facebook上。按日、周、月的时间顺序,

其实在我做前端的过程中,这类采集代码一开始都是f5采集器之类提供的,针对个人服务那种。如果想学习,

github中有很多,

百度搜索ifttt

有个叫echo技术社区的网站,

程序员_程序员论坛主站的javascript多语言版

采集工具(excel+word+access,为什么没有人推荐一个呢?)

采集交流 • 优采云 发表了文章 • 0 个评论 • 117 次浏览 • 2022-04-03 04:06

采集工具的话,推荐我们的企业微信运营助手,免费使用,一键采集公众号文章,智能标签、标签多渠道关键词采集、公众号文章多渠道搜索,

如果没有特殊需求的话,完全可以看专业的网站推广人员做的网站收集网站,以下是几个有名的收集网站——福布斯富豪榜:bloombergforelitewealth|fortunehorsemagazine(高净值俱乐部):,很全面的收集榜单和大咖列表。

自己挖的坟建了个微信公众号--企业微信引流群,

用excel模板批量采集,word文档随意修改部分,

一,大数据采集二,智能标签抓取三,

工具很多,百度搜一搜都有,我使用过的工具,可以解决好多难题,分享给你。【excel+word+access】一,工具电脑软件【excel+word+access】二,

为什么没有人推荐一个呢

还是excel+word+access,lietome,楼上说的都挺好的。

excel+word+access很不错

word+access+excel

可以上网站搜索这个学习。有道有学好数理化走遍天下都不怕。

可以上网站搜索这个学习

一个网站,36524网,可以注册做个自己的网站。

我做过一个免费的, 查看全部

采集工具(excel+word+access,为什么没有人推荐一个呢?)

采集工具的话,推荐我们的企业微信运营助手,免费使用,一键采集公众号文章,智能标签、标签多渠道关键词采集、公众号文章多渠道搜索,

如果没有特殊需求的话,完全可以看专业的网站推广人员做的网站收集网站,以下是几个有名的收集网站——福布斯富豪榜:bloombergforelitewealth|fortunehorsemagazine(高净值俱乐部):,很全面的收集榜单和大咖列表。

自己挖的坟建了个微信公众号--企业微信引流群,

用excel模板批量采集,word文档随意修改部分,

一,大数据采集二,智能标签抓取三,

工具很多,百度搜一搜都有,我使用过的工具,可以解决好多难题,分享给你。【excel+word+access】一,工具电脑软件【excel+word+access】二,

为什么没有人推荐一个呢

还是excel+word+access,lietome,楼上说的都挺好的。

excel+word+access很不错

word+access+excel

可以上网站搜索这个学习。有道有学好数理化走遍天下都不怕。

可以上网站搜索这个学习

一个网站,36524网,可以注册做个自己的网站。

我做过一个免费的,

采集工具(基于新浪新闻的全网搜索【iLab开发】思路:与第一种方法)

采集交流 • 优采云 发表了文章 • 0 个评论 • 122 次浏览 • 2022-03-30 03:13

这两天一直在帮李老师做采集“GEM”主题相关的网络资料,顺便研究了几个不同的网络资料工具采集,包括两个iLab Lab开发的采集工具和两个网上知名的网络资料采集工具。

一、基于谷歌/百度等搜索引擎的全网搜索[iLab开发]

思路:这种方法的基本原理是使用一个通用的搜索引擎,采集它的检索结果。通常取其搜索结果的前 100 页。源码是通过抓取搜索结果条目的url得到的,通过文本提取算法得到原文。因此,一个通用搜索引擎的所有功能,如多重关键词、现场检索等,都可以在这个工具中体现出来。

优点:搜索结果覆盖范围广。

缺点:如果想采集更具体的话题信息,需要指向垂直专业的站点(site:);搜索引擎返回的结果没有固定格式的模板,很难采集全文,只能使用一般的文本提取算法,目前准确率可以达到75%。

二、基于新浪新闻的全网搜索[iLab开发]

思路:与第一种方法类似,这里是新浪的新闻搜索平台。其索引范围包括新浪自己的新闻和其他网站新闻,全文和标题字段均可搜索。抓取方法同上。

优点:由于数据源为新闻报道,数据结构比较规范,便于提取原文。

缺点:覆盖面不足,针对新闻数据。

经测试,新浪搜索平台在标题字段中检索,主题相关性更强,新浪自有新闻数据保存较好。因此,我们的工具选择了采集“新浪新闻+标题”的检索方式得到的结果。

三、优采云

很早以前就听说过这个采集工具,但是前两天实际使用的时候,发现它的功能真的很强大。几乎任何浏览器都可以访问信息采集,还集成了分词等功能。在做多级链接采集和分页采集的时候也很方便。网上有免费版可供下载,商业版功能和售后服务更完善。

思路:优采云采集的基本思路是url采集+内容模板设置。它还提供全面的数据保存和发布功能。

优点:可以是 采集 特定的网站 和板;完全符合。

缺点:了解了它的所有特性后,发现优采云在我需要的范围内没有缺点。当然,也不是真的没有问题,只是大部分功能都有了。它还提供了用于功能扩展的开发接口。商业软件不一样!

优采云软件的帮助文档中有相关教程下载,操作也很简单。

四、在线精神

也是一个知名的网络信息采集工具,我没用过,你可以去官网看看。

最后是前面提到的我们实验室的采集工具,有需要的可以向我索取。该工具还集成了其他文本分析功能。 查看全部

采集工具(基于新浪新闻的全网搜索【iLab开发】思路:与第一种方法)

这两天一直在帮李老师做采集“GEM”主题相关的网络资料,顺便研究了几个不同的网络资料工具采集,包括两个iLab Lab开发的采集工具和两个网上知名的网络资料采集工具。

一、基于谷歌/百度等搜索引擎的全网搜索[iLab开发]

思路:这种方法的基本原理是使用一个通用的搜索引擎,采集它的检索结果。通常取其搜索结果的前 100 页。源码是通过抓取搜索结果条目的url得到的,通过文本提取算法得到原文。因此,一个通用搜索引擎的所有功能,如多重关键词、现场检索等,都可以在这个工具中体现出来。

优点:搜索结果覆盖范围广。

缺点:如果想采集更具体的话题信息,需要指向垂直专业的站点(site:);搜索引擎返回的结果没有固定格式的模板,很难采集全文,只能使用一般的文本提取算法,目前准确率可以达到75%。

二、基于新浪新闻的全网搜索[iLab开发]

思路:与第一种方法类似,这里是新浪的新闻搜索平台。其索引范围包括新浪自己的新闻和其他网站新闻,全文和标题字段均可搜索。抓取方法同上。

优点:由于数据源为新闻报道,数据结构比较规范,便于提取原文。

缺点:覆盖面不足,针对新闻数据。

经测试,新浪搜索平台在标题字段中检索,主题相关性更强,新浪自有新闻数据保存较好。因此,我们的工具选择了采集“新浪新闻+标题”的检索方式得到的结果。

三、优采云

很早以前就听说过这个采集工具,但是前两天实际使用的时候,发现它的功能真的很强大。几乎任何浏览器都可以访问信息采集,还集成了分词等功能。在做多级链接采集和分页采集的时候也很方便。网上有免费版可供下载,商业版功能和售后服务更完善。

思路:优采云采集的基本思路是url采集+内容模板设置。它还提供全面的数据保存和发布功能。

优点:可以是 采集 特定的网站 和板;完全符合。

缺点:了解了它的所有特性后,发现优采云在我需要的范围内没有缺点。当然,也不是真的没有问题,只是大部分功能都有了。它还提供了用于功能扩展的开发接口。商业软件不一样!

优采云软件的帮助文档中有相关教程下载,操作也很简单。

四、在线精神

也是一个知名的网络信息采集工具,我没用过,你可以去官网看看。

最后是前面提到的我们实验室的采集工具,有需要的可以向我索取。该工具还集成了其他文本分析功能。

采集工具(我推荐一个app:疯狂的,我想你都用过)

采集交流 • 优采云 发表了文章 • 0 个评论 • 115 次浏览 • 2022-03-29 20:04

采集工具我推荐一个app:疯狂的,我平时用来采集一些我喜欢的店铺的商品然后会自动同步到我微信里面,非常方便,

天猫精灵我想你都用过。只要你说你想开始,就可以训练。回答就是会。不过我开始的时候不晓得如何操作。

我上看到好物也会去上面去看。

我看大家的都是各种软件什么的,有人回答题主app的我也是醉了,没经历过吧。我是用了下助手的网站,然后点个“我想提取”,搜索你要的东西,然后点开它选择你想要的文件夹,最后就提取成功了。重要的是之前是要提取所有的商品文件,并且确保你想要的包括的商品都在,建议多操作几次。我是上完图上助手重新看一下,这里好像就不行,莫非要手动点开放在这里才行?!。

拿着自己的截图,去,

小亲亲采集器!超级强大

手机app里面都有。

我看大家都说用app软件,很是不以为然,我也推荐下载专门针对用户设计的助手,说好听点叫了解用户,说难听点就是操作不熟练,操作不明白,操作有困难,小编觉得是自己的问题,总是有运营,总是要走流量,总是要赚钱的,看那么多的技巧就知道了,

网上搜优惠券分享,正在用这个, 查看全部

采集工具(我推荐一个app:疯狂的,我想你都用过)

采集工具我推荐一个app:疯狂的,我平时用来采集一些我喜欢的店铺的商品然后会自动同步到我微信里面,非常方便,

天猫精灵我想你都用过。只要你说你想开始,就可以训练。回答就是会。不过我开始的时候不晓得如何操作。

我上看到好物也会去上面去看。

我看大家的都是各种软件什么的,有人回答题主app的我也是醉了,没经历过吧。我是用了下助手的网站,然后点个“我想提取”,搜索你要的东西,然后点开它选择你想要的文件夹,最后就提取成功了。重要的是之前是要提取所有的商品文件,并且确保你想要的包括的商品都在,建议多操作几次。我是上完图上助手重新看一下,这里好像就不行,莫非要手动点开放在这里才行?!。

拿着自己的截图,去,

小亲亲采集器!超级强大

手机app里面都有。

我看大家都说用app软件,很是不以为然,我也推荐下载专门针对用户设计的助手,说好听点叫了解用户,说难听点就是操作不熟练,操作不明白,操作有困难,小编觉得是自己的问题,总是有运营,总是要走流量,总是要赚钱的,看那么多的技巧就知道了,

网上搜优惠券分享,正在用这个,

采集工具(gmail不是采集工具,是恶意代码的吗?(一))

采集交流 • 优采云 发表了文章 • 0 个评论 • 101 次浏览 • 2022-03-28 21:04

采集工具本身没有攻击,就是恶意代码就是恶意的;收集到的一些协议没有沙箱不能用于攻击。具体的不展开。

论点:请注意,gmail不是采集工具。虽然我不懂技术,但是感觉这问题太笼统了,还是想不出一个好的答案,只能通过问答形式给个提纲吧。一般来说,如果采集任务是个单纯产出数据的完整流程,其实都是采集工具作恶啊。比如把一个网站的url完整抓取下来,那你得知道该怎么格式转化啊,用xml还是json啊,这些从本质上来说就是采集工具作恶,一般的采集工具都要求通过ssl+aes来做传输层和数据报文传输加密啊。

所以你看我们根本不认为它是恶意代码。就以电脑浏览器来说,我一直认为他是像上图那样是在解析你的http协议的,它不窃取你的任何私密信息,只是字面意义上的入侵而已。然后在拿到你的字节流之后,就对浏览器造成攻击了。目前各大浏览器都推出了专门的从源头上对它发起攻击的工具,我随便举个例子,ie,ie它就推出ip欺骗工具和钓鱼工具两个工具,你懂得,它这两个工具是为了阻止web安全协议的传输,是必须开启。

所以说,它的第二类攻击点就在于浏览器协议破解。我没查过网络协议的学术论文,但是这方面的可查的文章肯定远不止此。第三个采集工具我也认为是恶意代码,因为它造成的困扰远大于你提到的其他工具,比如在网站登录信息泄露的情况下使用(第二类攻击),或者在恶意代码篡改后的源码中包含它们的代码(第三类攻击)。--再补充一下,需要说明的是采集工具不是模拟,就拿我自己采集信息的例子来说,我是通过,在采集数据的过程中还使用了cookie来调用“宝贝”的guid值来判断对方的电话号码是否和上次购买商品类似,这样可以作为判断的依据。

在这里提一下:我一直说的网站采集算是代理登录的类型,不是真的和电脑同步采集。例如我这里抓取的以及cnzz(具体的问题可以去博客或知乎搜)都是不记名的,也不像我说的第三类工具这样,有真实号码。 查看全部

采集工具(gmail不是采集工具,是恶意代码的吗?(一))

采集工具本身没有攻击,就是恶意代码就是恶意的;收集到的一些协议没有沙箱不能用于攻击。具体的不展开。

论点:请注意,gmail不是采集工具。虽然我不懂技术,但是感觉这问题太笼统了,还是想不出一个好的答案,只能通过问答形式给个提纲吧。一般来说,如果采集任务是个单纯产出数据的完整流程,其实都是采集工具作恶啊。比如把一个网站的url完整抓取下来,那你得知道该怎么格式转化啊,用xml还是json啊,这些从本质上来说就是采集工具作恶,一般的采集工具都要求通过ssl+aes来做传输层和数据报文传输加密啊。

所以你看我们根本不认为它是恶意代码。就以电脑浏览器来说,我一直认为他是像上图那样是在解析你的http协议的,它不窃取你的任何私密信息,只是字面意义上的入侵而已。然后在拿到你的字节流之后,就对浏览器造成攻击了。目前各大浏览器都推出了专门的从源头上对它发起攻击的工具,我随便举个例子,ie,ie它就推出ip欺骗工具和钓鱼工具两个工具,你懂得,它这两个工具是为了阻止web安全协议的传输,是必须开启。

所以说,它的第二类攻击点就在于浏览器协议破解。我没查过网络协议的学术论文,但是这方面的可查的文章肯定远不止此。第三个采集工具我也认为是恶意代码,因为它造成的困扰远大于你提到的其他工具,比如在网站登录信息泄露的情况下使用(第二类攻击),或者在恶意代码篡改后的源码中包含它们的代码(第三类攻击)。--再补充一下,需要说明的是采集工具不是模拟,就拿我自己采集信息的例子来说,我是通过,在采集数据的过程中还使用了cookie来调用“宝贝”的guid值来判断对方的电话号码是否和上次购买商品类似,这样可以作为判断的依据。

在这里提一下:我一直说的网站采集算是代理登录的类型,不是真的和电脑同步采集。例如我这里抓取的以及cnzz(具体的问题可以去博客或知乎搜)都是不记名的,也不像我说的第三类工具这样,有真实号码。

采集工具(如何使用简单好用的Zblog采集插件工具快速采集排名获取流量)

采集交流 • 优采云 发表了文章 • 0 个评论 • 146 次浏览 • 2022-03-24 23:03

如何使用Zblog采集插件工具快速采集流量排名。最近有很多朋友向我抱怨说我用Zblog采集插件管理不了十个网站。他们每天检查采集 规则,仅仅编写采集 规则就需要很多时间。如果你精通 HTML+css 编写规则会快很多,如果你不熟悉代码。需要更多时间。

案例图

如何使用简单易用的Zblog采集工具快速采集排名并批量获取流量

如何批量管理 Zblog 网站:

一、有批次管理检查工具

Zblog批量发布检测工具

1、监控数据:软件直接监控发布数量,待发布数量,伪原创是否成功,发布状态(是否发布成功),发布网站@ >、发布程序、发布时间等。

详细解答:无论是易友、ZBLOG、织梦、WP、PB、Apple、Sowai等各大cms,都可以同时支持批量管理和发布工具。不同栏目设置不同关键词文章定期发布+每日总发布+数据监控=完美解决低效问题。

二、 Zblog 批处理采集工具

Zblog 批量采集工具

1、 Bulk采集:如果每个 网站 都花费大量时间编写 采集Applecms采集插件的规则,那么就不用再花时间管理 网站 和分析 网站 数据了!批量采集 选择 Zblogs 很重要。它必须易于操作。批处理 采集 只能通过简单的操作来实现。

详细解答:只需导入关键词即可采集相关关键词文章,同时创建几十个或上百个喜欢的任务(一个任务可支持上传1000个关键词@ >文章 @关键词) 什么是苹果的cms采集 插件,支持大平台合集。 (搜狗资讯-微信公众号-搜狗知乎-头条资讯-百度资讯-百度知道-新浪新闻-360资讯-凤凰资讯等,可同时设置多个采集来源采集)

实现自动批量挂机采集,无缝对接各大cms发布者,实现自动挂机采集和发布。

如何实现快速的批量收录和排名:

搜索引擎推送工具

网站刚成立时,搜索引擎会调查网站一段时间,而这段时间对于网站来说是最重要的时期。为了让搜索引擎能够收录网站文章,我们必须积极引导搜索引擎蜘蛛抓取网站文章的内容。

如何快速获取网站流量:网站内容→网站收录→流量排名 查看全部

采集工具(如何使用简单好用的Zblog采集插件工具快速采集排名获取流量)

如何使用Zblog采集插件工具快速采集流量排名。最近有很多朋友向我抱怨说我用Zblog采集插件管理不了十个网站。他们每天检查采集 规则,仅仅编写采集 规则就需要很多时间。如果你精通 HTML+css 编写规则会快很多,如果你不熟悉代码。需要更多时间。

案例图

如何使用简单易用的Zblog采集工具快速采集排名并批量获取流量

如何批量管理 Zblog 网站:

一、有批次管理检查工具

Zblog批量发布检测工具

1、监控数据:软件直接监控发布数量,待发布数量,伪原创是否成功,发布状态(是否发布成功),发布网站@ >、发布程序、发布时间等。

详细解答:无论是易友、ZBLOG、织梦、WP、PB、Apple、Sowai等各大cms,都可以同时支持批量管理和发布工具。不同栏目设置不同关键词文章定期发布+每日总发布+数据监控=完美解决低效问题。

二、 Zblog 批处理采集工具

Zblog 批量采集工具

1、 Bulk采集:如果每个 网站 都花费大量时间编写 采集Applecms采集插件的规则,那么就不用再花时间管理 网站 和分析 网站 数据了!批量采集 选择 Zblogs 很重要。它必须易于操作。批处理 采集 只能通过简单的操作来实现。

详细解答:只需导入关键词即可采集相关关键词文章,同时创建几十个或上百个喜欢的任务(一个任务可支持上传1000个关键词@ >文章 @关键词) 什么是苹果的cms采集 插件,支持大平台合集。 (搜狗资讯-微信公众号-搜狗知乎-头条资讯-百度资讯-百度知道-新浪新闻-360资讯-凤凰资讯等,可同时设置多个采集来源采集)

实现自动批量挂机采集,无缝对接各大cms发布者,实现自动挂机采集和发布。

如何实现快速的批量收录和排名:

搜索引擎推送工具

网站刚成立时,搜索引擎会调查网站一段时间,而这段时间对于网站来说是最重要的时期。为了让搜索引擎能够收录网站文章,我们必须积极引导搜索引擎蜘蛛抓取网站文章的内容。

如何快速获取网站流量:网站内容→网站收录→流量排名

采集工具( 百分百企业名录搜索软件会定期整理最新的企业信息采集软件)

采集交流 • 优采云 发表了文章 • 0 个评论 • 136 次浏览 • 2022-03-21 17:11

百分百企业名录搜索软件会定期整理最新的企业信息采集软件)

百分百企业名录搜索软件是一款准确有效的企业信息采集软件,用户可以根据关键词、地区、行业或自定义搜索条件,准确采集到企业的联系人,手机号、邮箱等工具,快捷高效。采集完成后,就可以自行导出数据了。100%企业名录搜索软件会定期整理最新的企业名录数据,保证用户采集的数据是最新的、可用的。

100%企业名录搜索软件功能

1、按地区生成手机号码

手机号码段根据用户设置的地区生成,可根据指定的号码段和自定义格式生成手机号码,是地域定向营销和群发短信的最佳选择。

2、在线采集通过B2B网站

软件可通过B2B网站online采集访问,如慧聪网、马可波罗、亿虎百影、中国供应商等。B2B网站采集最新企业信息,数据准确,采集速度快,对于想要获取最新企业信息的客户来说是不错的选择

3、百度爬虫采集手机号,目标准确

软件支持网络爬虫搜索手机号功能,根据你的关键词智能搜索百度用户的手机号,目标精准清晰,搜索结果(即手机号)可本地保存,网络营销必备助手

4、覆盖全国各行各业

经我司官方人员精心整理分类,再经过程序的二次精准处理,我司数据库已覆盖全国所有行业,每个行业对应的数据都已定位准确。它是您的发展寻找新客户和潜在客户的最佳工具

5、数据及时更新,保证营销效果

100%的团队,专业的员工,定期整理最新的企业名录数据,我们力求及时更新最新的企业数据,同时优化旧的企业数据,确保您采集通过我们的软件。企业数据是第一手的和最新的。为了您取得更好的营销和销售效果,我们一直在努力

6、采集速度快,稳定性好

软件采用我们团队两年开发的软件内核,在不添加群组的情况下提取群组成员,并利用现有成熟技术力求为您达到最佳的采集速度,而软件的稳定性不完全受影响!不仅可以节省您的时间和效率,还可以让您的营销更省心

7、快速便捷的数据导出,多种格式

凡是购买了我们的软件并成为正式版用户的人,都可以享受软件的导出功能。导出格式,我们支持execel、txt等基本格式,同时我们有人性化的自定义导出格式设置,可以随意导出自己需要的格式

8、软件采用网络账号,不限机器

100%客户整合采集软件采用网络账号形式。一个软件账号可以登录不同的电脑。用户可以在家中或公司使用。它以机器码的形式摆脱了传统软件的弊端。实现以用户为中心、以服务为基础的群发理念

9、软件不断升级完善,售后服务可靠

在升级和维护方面,100%软件团队一直坚持技术创新和脚踏实地的维护,确保软件功能和性能的稳定性。在售后服务方面,百分百软件团队拥有一支训练有素的客服团队,为您提供专业的技术支持

100%企业目录搜索软件使用

⑴首先打开100%软件,可以登录软件账号或者免费试用软件!

(2) 设置要搜索的企业的条件,包括要搜索的关键词和企业所属的行业。您可以一次设置多个 关键词。

(3) 开始搜索企业目录,搜索到的企业目录会显示在显示框中。

⑷搜索成功后,选择目标公司目录,点击导出,将公司目录导出,可以excel和txt格式导出(试用版不支持导出)。

⑹ 试用满意后联系客服购买正式版软件,享受免费升级服务、问答、售后服务。

100% 企业名录搜索软件常见问题解答

(一)免费试用软件有一定的功能限制,限制搜索数据的导出!如果想无限制使用,请购买正版。

(二) Q:软件数据会定期更新吗?多久更新一次?

A:软件采用独创方式,定期更新公司目录和数据库,保证大家的使用效果和用户权限!软件实时更新数据,只要我们官方抓取最新的公司目录,就会第一时间更新并入库!

(三)如果您在使用过程中有任何问题或想对软件改进提出建议,请联系我们的客服进行指导,我们将尽快为您解决问题! 查看全部

采集工具(

百分百企业名录搜索软件会定期整理最新的企业信息采集软件)

百分百企业名录搜索软件是一款准确有效的企业信息采集软件,用户可以根据关键词、地区、行业或自定义搜索条件,准确采集到企业的联系人,手机号、邮箱等工具,快捷高效。采集完成后,就可以自行导出数据了。100%企业名录搜索软件会定期整理最新的企业名录数据,保证用户采集的数据是最新的、可用的。

100%企业名录搜索软件功能

1、按地区生成手机号码

手机号码段根据用户设置的地区生成,可根据指定的号码段和自定义格式生成手机号码,是地域定向营销和群发短信的最佳选择。

2、在线采集通过B2B网站

软件可通过B2B网站online采集访问,如慧聪网、马可波罗、亿虎百影、中国供应商等。B2B网站采集最新企业信息,数据准确,采集速度快,对于想要获取最新企业信息的客户来说是不错的选择

3、百度爬虫采集手机号,目标准确

软件支持网络爬虫搜索手机号功能,根据你的关键词智能搜索百度用户的手机号,目标精准清晰,搜索结果(即手机号)可本地保存,网络营销必备助手

4、覆盖全国各行各业

经我司官方人员精心整理分类,再经过程序的二次精准处理,我司数据库已覆盖全国所有行业,每个行业对应的数据都已定位准确。它是您的发展寻找新客户和潜在客户的最佳工具

5、数据及时更新,保证营销效果

100%的团队,专业的员工,定期整理最新的企业名录数据,我们力求及时更新最新的企业数据,同时优化旧的企业数据,确保您采集通过我们的软件。企业数据是第一手的和最新的。为了您取得更好的营销和销售效果,我们一直在努力

6、采集速度快,稳定性好

软件采用我们团队两年开发的软件内核,在不添加群组的情况下提取群组成员,并利用现有成熟技术力求为您达到最佳的采集速度,而软件的稳定性不完全受影响!不仅可以节省您的时间和效率,还可以让您的营销更省心

7、快速便捷的数据导出,多种格式

凡是购买了我们的软件并成为正式版用户的人,都可以享受软件的导出功能。导出格式,我们支持execel、txt等基本格式,同时我们有人性化的自定义导出格式设置,可以随意导出自己需要的格式

8、软件采用网络账号,不限机器

100%客户整合采集软件采用网络账号形式。一个软件账号可以登录不同的电脑。用户可以在家中或公司使用。它以机器码的形式摆脱了传统软件的弊端。实现以用户为中心、以服务为基础的群发理念

9、软件不断升级完善,售后服务可靠

在升级和维护方面,100%软件团队一直坚持技术创新和脚踏实地的维护,确保软件功能和性能的稳定性。在售后服务方面,百分百软件团队拥有一支训练有素的客服团队,为您提供专业的技术支持

100%企业目录搜索软件使用

⑴首先打开100%软件,可以登录软件账号或者免费试用软件!

(2) 设置要搜索的企业的条件,包括要搜索的关键词和企业所属的行业。您可以一次设置多个 关键词。

(3) 开始搜索企业目录,搜索到的企业目录会显示在显示框中。

⑷搜索成功后,选择目标公司目录,点击导出,将公司目录导出,可以excel和txt格式导出(试用版不支持导出)。

⑹ 试用满意后联系客服购买正式版软件,享受免费升级服务、问答、售后服务。

100% 企业名录搜索软件常见问题解答

(一)免费试用软件有一定的功能限制,限制搜索数据的导出!如果想无限制使用,请购买正版。

(二) Q:软件数据会定期更新吗?多久更新一次?

A:软件采用独创方式,定期更新公司目录和数据库,保证大家的使用效果和用户权限!软件实时更新数据,只要我们官方抓取最新的公司目录,就会第一时间更新并入库!

(三)如果您在使用过程中有任何问题或想对软件改进提出建议,请联系我们的客服进行指导,我们将尽快为您解决问题!

采集工具(采集工具python爬虫实现小客流量统计分析及动态仿真训练)

采集交流 • 优采云 发表了文章 • 0 个评论 • 127 次浏览 • 2022-03-17 18:01

采集工具python爬虫实现小客流量统计分析及动态仿真训练

肯定要requests,楼上的推荐动态数据seaborn+requests,其实可以不用考虑,因为seaborn比动态数据老,爬动态数据用seaborn就好了,不过如果你是要找一些更好玩,自己定制的更多的数据分析pipeline,是可以选择seaborn来做,比如可以搞定更多定制的数据分析,机器学习模型设计。

不推荐使用requests,因为requests解析上面这段代码是没有什么问题的。自己写个cookie池,增加下requests在登录过程中的存储,还是可以的。set也不错,但是如果web相关的服务稍微依赖set,那就算了吧。机器学习模型的仿真,可以使用seaborn。

python最好还是别用requests

上面的都推荐动态数据,说实话,requests其实有点过时,也不是很准确,个人意见,现在python的框架这么多,可以适当使用动态数据,最近在做机器学习,推荐luosam的机器学习框架,推荐理由:它既可以运行在windows下,也可以运行在linux/mac等跨平台下,架构也比较紧凑,所以,我们可以拿python模拟requests客户端,实现动态数据的抓取。

requests就足够了,requests官网上有示例代码,但是实际应用的话,主要考虑两个问题,如果用cookie登录,可以用nosec服务,在requests里加一些代码,自动提取邮箱地址;如果是用node.js访问,可以考虑swoole来实现。爬虫是建立在数据收集与处理上的,加上性能问题,建议还是采用更先进的工具吧。 查看全部

采集工具(采集工具python爬虫实现小客流量统计分析及动态仿真训练)

采集工具python爬虫实现小客流量统计分析及动态仿真训练

肯定要requests,楼上的推荐动态数据seaborn+requests,其实可以不用考虑,因为seaborn比动态数据老,爬动态数据用seaborn就好了,不过如果你是要找一些更好玩,自己定制的更多的数据分析pipeline,是可以选择seaborn来做,比如可以搞定更多定制的数据分析,机器学习模型设计。

不推荐使用requests,因为requests解析上面这段代码是没有什么问题的。自己写个cookie池,增加下requests在登录过程中的存储,还是可以的。set也不错,但是如果web相关的服务稍微依赖set,那就算了吧。机器学习模型的仿真,可以使用seaborn。

python最好还是别用requests

上面的都推荐动态数据,说实话,requests其实有点过时,也不是很准确,个人意见,现在python的框架这么多,可以适当使用动态数据,最近在做机器学习,推荐luosam的机器学习框架,推荐理由:它既可以运行在windows下,也可以运行在linux/mac等跨平台下,架构也比较紧凑,所以,我们可以拿python模拟requests客户端,实现动态数据的抓取。

requests就足够了,requests官网上有示例代码,但是实际应用的话,主要考虑两个问题,如果用cookie登录,可以用nosec服务,在requests里加一些代码,自动提取邮箱地址;如果是用node.js访问,可以考虑swoole来实现。爬虫是建立在数据收集与处理上的,加上性能问题,建议还是采用更先进的工具吧。

采集工具(荷兰linux采集工具解析:拥有非常多的linux平台上线下兼容的浏览器插件功能)

采集交流 • 优采云 发表了文章 • 0 个评论 • 145 次浏览 • 2022-03-15 09:05

采集工具解析:拥有非常多的linux平台上线下兼容的采集工具,大部分都具有浏览器插件功能,对于采集工具自己来说不需要做任何改变,

1、duckduckgo,/是一款由荷兰的kleejan2015年发布的一款http/https抓取工具,支持4大流行的网站类型:视频、图片、地图、音乐,无需注册,

2、kwfield,/,为网站进行http/https、websites整站抓取,其中http抓取,可以抓取国内外的新闻等,https抓取,

3、fiddler,支持,整站抓取,配合squid/metasploit工具,

4、awesome-javascript,抓取国内外网站进行单站抓取,可以爬取百度、谷歌搜索引擎的数据,目前github上已经有5000+star,可抓取谷歌自己的站点,然后上传github让其他人修改,

5、bigjpg,支持全球站点抓取,生成全球站点地图,抓取国内外新闻网站,配合wget/jsoup/xpath工具一键实现。

6、51cto,采集多站点的网站热点信息,提供大量的国内外网站地图,类似谷歌的热点图,可抓取百度、google搜索引擎的数据!本文由兴趣交流群社群友友提供,由内容社群友友提供,该工具只支持python3,python2.x需要另行获取!下载地址:采集可以直接使用这些免费工具使用即可。 查看全部

采集工具(荷兰linux采集工具解析:拥有非常多的linux平台上线下兼容的浏览器插件功能)

采集工具解析:拥有非常多的linux平台上线下兼容的采集工具,大部分都具有浏览器插件功能,对于采集工具自己来说不需要做任何改变,

1、duckduckgo,/是一款由荷兰的kleejan2015年发布的一款http/https抓取工具,支持4大流行的网站类型:视频、图片、地图、音乐,无需注册,

2、kwfield,/,为网站进行http/https、websites整站抓取,其中http抓取,可以抓取国内外的新闻等,https抓取,

3、fiddler,支持,整站抓取,配合squid/metasploit工具,

4、awesome-javascript,抓取国内外网站进行单站抓取,可以爬取百度、谷歌搜索引擎的数据,目前github上已经有5000+star,可抓取谷歌自己的站点,然后上传github让其他人修改,

5、bigjpg,支持全球站点抓取,生成全球站点地图,抓取国内外新闻网站,配合wget/jsoup/xpath工具一键实现。

6、51cto,采集多站点的网站热点信息,提供大量的国内外网站地图,类似谷歌的热点图,可抓取百度、google搜索引擎的数据!本文由兴趣交流群社群友友提供,由内容社群友友提供,该工具只支持python3,python2.x需要另行获取!下载地址:采集可以直接使用这些免费工具使用即可。

采集工具(为什么这么多人选择Zbog?Z-Blog是一款基于ASP/PHP平台的网站程序)

采集交流 • 优采云 发表了文章 • 0 个评论 • 139 次浏览 • 2022-03-11 09:02

2、通过ZBLOG批量发布管理工具,可以直接看到文章的发布数量,文章要发布的数量,伪原创是否为成功,发布的URL等。支持除Zblog之外的所有主要cms平台。还可以设置定时发布(SEO人员在优化网站的时候可以设置定时发布,这样搜索引擎抓取的频率会更高,而且对于整个网站,会不断增加权重.网站的权重越高,未来被搜索的机会就越多。)

不用担心 网站 太多而无法管理! SEO人员再也不用费心来回切换网站后台,反复登录后台是件很痛苦的事情

在这个内容为王的时代,SEO人员应该明白,大量的网站内容是支撑流量的基础。 关键词排名越多流量越大,但是原创文章难度太高成本太高,很多网站不可能每天保持大量的原创内容输出,所以更频繁。

为什么这么多人选择Zbog?

Z-Blog是一个基于ASP/PHP平台的网站程序。 Z-Blog 具有丰富而强大的可定制性。作为一个cms系统,Z-Blog可以更方便的管理和扩展你的网站。首先,Zblog应用中心拥有大量的插件和模板,功能强大。只要精通HTML+CSS+JS,就可以轻松制作出精美的模板。只要你懂ASP或PHP,就可以制作Z-Blog插件或主题模板,并集成Z-Blog应用中心功能,从后台简单下载你想要的主题模板和插件。

在 SEO 方面,WordPress 在 Google 中可能比 Zblog 有更大的优势,相反,百度的搜索优势会大于 WordPress。总之,WordPress的优化和推广还是要看SEOer如何优化。其实并不是很多人说的先天程序,而是比较方便的DIY,最终效果取决于自己的SEO水平和项目决策。 查看全部

采集工具(为什么这么多人选择Zbog?Z-Blog是一款基于ASP/PHP平台的网站程序)

2、通过ZBLOG批量发布管理工具,可以直接看到文章的发布数量,文章要发布的数量,伪原创是否为成功,发布的URL等。支持除Zblog之外的所有主要cms平台。还可以设置定时发布(SEO人员在优化网站的时候可以设置定时发布,这样搜索引擎抓取的频率会更高,而且对于整个网站,会不断增加权重.网站的权重越高,未来被搜索的机会就越多。)

不用担心 网站 太多而无法管理! SEO人员再也不用费心来回切换网站后台,反复登录后台是件很痛苦的事情

在这个内容为王的时代,SEO人员应该明白,大量的网站内容是支撑流量的基础。 关键词排名越多流量越大,但是原创文章难度太高成本太高,很多网站不可能每天保持大量的原创内容输出,所以更频繁。

为什么这么多人选择Zbog?

Z-Blog是一个基于ASP/PHP平台的网站程序。 Z-Blog 具有丰富而强大的可定制性。作为一个cms系统,Z-Blog可以更方便的管理和扩展你的网站。首先,Zblog应用中心拥有大量的插件和模板,功能强大。只要精通HTML+CSS+JS,就可以轻松制作出精美的模板。只要你懂ASP或PHP,就可以制作Z-Blog插件或主题模板,并集成Z-Blog应用中心功能,从后台简单下载你想要的主题模板和插件。

在 SEO 方面,WordPress 在 Google 中可能比 Zblog 有更大的优势,相反,百度的搜索优势会大于 WordPress。总之,WordPress的优化和推广还是要看SEOer如何优化。其实并不是很多人说的先天程序,而是比较方便的DIY,最终效果取决于自己的SEO水平和项目决策。

采集工具(如何从大数据中采集出有用的信息是大数据发展的最关键因素)

采集交流 • 优采云 发表了文章 • 0 个评论 • 102 次浏览 • 2022-03-07 18:16

大数据有多种来源。在大数据时代背景下,如何从大数据中获取有用信息是大数据发展的最关键因素。大数据采集是大数据产业的基石,大数据采集阶段的工作是大数据的核心技术之一。为了高效地采集大数据,关键是要根据采集环境和数据类型选择合适的大数据采集方法和平台。下面介绍一些常用的大数据采集平台和工具。

1个水槽

Flume 作为 Hadoop 的一个组件,是 Cloudera 专门开发的分布式日志采集系统。尤其是近年来,随着 Flume 的不断完善,用户在开发过程中的便利性有了很大的提升,Flume 现已成为 Apache Top 项目之一。

Flume提供了从Console(控制台)、RPC(Thrift-RPC)、Text(文件)、Tail(UNIX Tail)、Syslog、Exec(命令执行)等数据源采集数据的能力。

Flume 采用了多 Master 的方式。为了保证配置数据的一致性,Flume 引入了 ZooKeeper 来保存配置数据。ZooKeeper 本身保证了配置数据的一致性和高可用性。此外,ZooKeeper 可以在配置数据发生变化时通知 Flume Master 节点。Gossip 协议用于在 Flume Master 节点之间同步数据。

Flume对于特殊场景也有很好的自定义扩展能力,所以Flume适用于大部分日常数据采集的场景。因为 Flume 是用 JRuby 构建的,所以它依赖于 Java 运行时环境。Flume 被设计成一种分布式管道架构,可以看作是数据源和目的地之间的代理网络,以支持数据路由。

Flume 支持设置 Sink 的 Failover 和负载均衡,保证在一个 Agent 发生故障时整个系统仍然可以正常采集数据。Flume中传输的内容被定义为一个事件,一个事件由Headers(包括元数据,即Meta Data)和Payload组成。

Flume 提供 SDK,可以支持用户定制开发。Flume 客户端负责将事件发送到事件源的 Flume 代理。客户端通常与生成数据源的应用程序位于同一进程空间中。常见的 Flume 客户端是 Avro、Log4J、Syslog 和 HTTP Post。

2 流利

Fluentd 是另一种开源数据采集架构,如图 1 所示。Fluentd 是用 C/Ruby 开发的,使用 JSON 文件来统一日志数据。通过丰富的插件,您可以采集各种系统或应用程序的日志,然后根据用户定义对日志进行分类。使用 Fluentd,跟踪日志文件、过滤它们并将它们转储到 MongoDB 等操作非常容易。Fluentd 可以将人们从繁琐的日志处理中彻底解放出来。

图 1 Fluentd 架构

Fluentd 具有多种特性:易于安装、占用空间小、半结构化数据记录、灵活的插件机制、可靠的缓冲和日志转发。为本产品提供支持和维护。此外,使用 JSON 统一的数据/日志格式是它的另一个特点。与 Flume 相比,Fluentd 的配置相对简单。

Fluentd 的扩展性很强,客户可以自己定制(Ruby)Input/Buffer/Output。Fluentd 存在跨平台问题,不支持 Windows 平台。

Fluentd 的 Input/Buffer/Output 与 Flume 的 Source/Channel/Sink 非常相似。Fluentd 架构如图 2 所示。

图 2 Fluentd 架构

3 日志存储

Logstash 是著名的开源数据栈 ELK(ElasticSearch、Logstash、Kibana)中的 L。因为 Logstash 是用 JRuby 开发的,所以运行时依赖于 JVM。Logstash的部署架构如图3所示。当然,这只是一个部署选项。

图3 Logstash的部署架构

一个典型的 Logstash 配置如下,包括 Input 和 Filter 的 Output 的设置。

输入 {

文件 {

类型 => “Apache 访问”

路径 =>“/var/log/Apache2/other_vhosts_access.log”

}

文件 {

类型=>“补丁错误”

路径 =>“/var/log/Apache2/error.log”

}

}

筛选 {

摸索{

匹配 => {"消息"=>"%(COMBINEDApacheLOG)"}

}

日期 {

匹配 => {"时间戳"=>"dd/MMM/yyyy:HH:mm:ss Z"}

}

}

输出 {

标准输出 {}

雷迪斯 {

主机="192.168.1.289"

data_type => "列表"

键=>“Logstash”

}

}

几乎在大多数情况下,ELK 同时用作堆栈。在您的数据系统使用 ElasticSearch 的情况下,Logstash 是首选。

4 楚夸

Chukwa 是 Apache 旗下的另一个开源数据采集平台,知名度远不如其他平台。Chukwa 建立在 Hadoop 的 HDFS 和 MapReduce(用 Java 实现)之上,以提供可扩展性和可靠性。它提供了许多模块来支持 Hadoop 集群日志分析。Chukwa 还提供数据展示、分析和监控。该项目目前处于非活动状态。

Chukwa 满足以下需求:

(1)灵活、动态可控的数据源。

(2)高性能、高度可扩展的存储系统。

(3)用于分析采集的大规模数据的适当架构。

Chukwa 架构如图 4 所示。

图 4 Chukwa 架构

5 抄写员

Scribe 是 Facebook 开发的数据(日志)采集系统。其官网多年未维护。Scribe 为日志的“分布式采集、统一处理”提供了可扩展和容错的解决方案。当中央存储系统的网络或机器出现故障时,Scribe 会将日志转储到本地或其他位置;当中央存储系统恢复时,Scribe 会将转储的日志重新传输到中央存储系统。Scribe 通常与 Hadoop 结合使用,将日志推送(push)到 HDFS 中,由 MapReduce 作业定期处理。

Scribe 架构如图 5 所示。

图 5 Scribe 架构

Scribe 架构比较简单,主要包括三个部分,即 Scribe 代理、Scribe 和存储系统。

6 斯普伦克

在商用大数据平台产品中,Splunk提供完整的数据采集、数据存储、数据分析处理、数据呈现能力。Splunk 是一个分布式机器数据平台,具有三个主要角色。Splunk 架构如图 6 所示。

图 6 Splunk 架构

搜索:负责数据的搜索和处理,在搜索过程中提供信息提取功能。

Indexer:负责数据的存储和索引。

Forwarder:负责数据的采集、清洗、变形、发送到Indexer。

Splunk 内置了对 Syslog、TCP/UDP 和 Spooling 的支持。同时,用户可以通过开发 Input 和 Modular Input 来获取特定的数据。Splunk提供的软件仓库中有很多成熟的数据采集应用,比如AWS、数据库(DBConnect)等,可以很方便的从云端或者数据库中获取数据,输入到Splunk数据平台进行分析。

Search Head和Indexer都支持Cluster配置,即高可用和高扩展,但是Splunk还没有Forwarder的Cluster功能。也就是说,如果一台Forwarder机器出现故障,数据采集将中断,正在运行的数据采集任务无法故障转移到其他Forwarder。

7 刮擦

Python 的爬虫架构称为 Scrapy。Scrapy 是一个用 Python 语言开发的快速、高级的屏幕抓取和网页抓取框架,用于抓取网站并从页面中提取结构化数据。Scrapy 用途广泛,可用于数据挖掘、监控和自动化测试。

Scrapy 的吸引力在于它是一种任何人都可以根据需要轻松修改的架构。还提供了各类爬虫的基类,如BaseSpider、Sitemap爬虫等。最新版本提供了对Web2.0爬虫的支持。

Scrapy的工作原理如图7所示。

图 7 Scrapy 运行原理

Scrapy 的整个数据处理流程由 Scrapy 引擎控制。Scrapy运行过程如下:

(1)当Scrapy引擎打开一个域名时,爬虫对域名进行处理,让爬虫获取第一个爬取的URL。

(2)Scrapy引擎首先从爬虫中获取第一个需要爬取的URL,然后在调度中将其作为请求调度。

(3)Scrapy 引擎从调度程序获取要抓取的下一页。

(4)Schedule将下一次爬取的URL返回给引擎,引擎通过下载中间件发送给下载器。

(5)下载器下载网页时,通过下载器中间件将响应内容发送给Scrapy引擎。

(6)Scrapy引擎接收到下载器的响应,通过爬虫中间件发送给爬虫进行处理。

(7)爬虫处理响应并返回爬取的项目,然后向Scrapy引擎发送新的请求。

(8)Scrapy 引擎将抓取的项目放入项目管道并向调度程序发送请求。

(9)系统重复(2)步骤之后的操作,直到调度器中没有请求,然后断开Scrapy引擎与域的连接。 查看全部

采集工具(如何从大数据中采集出有用的信息是大数据发展的最关键因素)

大数据有多种来源。在大数据时代背景下,如何从大数据中获取有用信息是大数据发展的最关键因素。大数据采集是大数据产业的基石,大数据采集阶段的工作是大数据的核心技术之一。为了高效地采集大数据,关键是要根据采集环境和数据类型选择合适的大数据采集方法和平台。下面介绍一些常用的大数据采集平台和工具。

1个水槽

Flume 作为 Hadoop 的一个组件,是 Cloudera 专门开发的分布式日志采集系统。尤其是近年来,随着 Flume 的不断完善,用户在开发过程中的便利性有了很大的提升,Flume 现已成为 Apache Top 项目之一。

Flume提供了从Console(控制台)、RPC(Thrift-RPC)、Text(文件)、Tail(UNIX Tail)、Syslog、Exec(命令执行)等数据源采集数据的能力。

Flume 采用了多 Master 的方式。为了保证配置数据的一致性,Flume 引入了 ZooKeeper 来保存配置数据。ZooKeeper 本身保证了配置数据的一致性和高可用性。此外,ZooKeeper 可以在配置数据发生变化时通知 Flume Master 节点。Gossip 协议用于在 Flume Master 节点之间同步数据。

Flume对于特殊场景也有很好的自定义扩展能力,所以Flume适用于大部分日常数据采集的场景。因为 Flume 是用 JRuby 构建的,所以它依赖于 Java 运行时环境。Flume 被设计成一种分布式管道架构,可以看作是数据源和目的地之间的代理网络,以支持数据路由。

Flume 支持设置 Sink 的 Failover 和负载均衡,保证在一个 Agent 发生故障时整个系统仍然可以正常采集数据。Flume中传输的内容被定义为一个事件,一个事件由Headers(包括元数据,即Meta Data)和Payload组成。

Flume 提供 SDK,可以支持用户定制开发。Flume 客户端负责将事件发送到事件源的 Flume 代理。客户端通常与生成数据源的应用程序位于同一进程空间中。常见的 Flume 客户端是 Avro、Log4J、Syslog 和 HTTP Post。

2 流利

Fluentd 是另一种开源数据采集架构,如图 1 所示。Fluentd 是用 C/Ruby 开发的,使用 JSON 文件来统一日志数据。通过丰富的插件,您可以采集各种系统或应用程序的日志,然后根据用户定义对日志进行分类。使用 Fluentd,跟踪日志文件、过滤它们并将它们转储到 MongoDB 等操作非常容易。Fluentd 可以将人们从繁琐的日志处理中彻底解放出来。

图 1 Fluentd 架构

Fluentd 具有多种特性:易于安装、占用空间小、半结构化数据记录、灵活的插件机制、可靠的缓冲和日志转发。为本产品提供支持和维护。此外,使用 JSON 统一的数据/日志格式是它的另一个特点。与 Flume 相比,Fluentd 的配置相对简单。

Fluentd 的扩展性很强,客户可以自己定制(Ruby)Input/Buffer/Output。Fluentd 存在跨平台问题,不支持 Windows 平台。

Fluentd 的 Input/Buffer/Output 与 Flume 的 Source/Channel/Sink 非常相似。Fluentd 架构如图 2 所示。

图 2 Fluentd 架构

3 日志存储

Logstash 是著名的开源数据栈 ELK(ElasticSearch、Logstash、Kibana)中的 L。因为 Logstash 是用 JRuby 开发的,所以运行时依赖于 JVM。Logstash的部署架构如图3所示。当然,这只是一个部署选项。

图3 Logstash的部署架构

一个典型的 Logstash 配置如下,包括 Input 和 Filter 的 Output 的设置。

输入 {

文件 {

类型 => “Apache 访问”

路径 =>“/var/log/Apache2/other_vhosts_access.log”

}

文件 {

类型=>“补丁错误”

路径 =>“/var/log/Apache2/error.log”

}

}

筛选 {

摸索{

匹配 => {"消息"=>"%(COMBINEDApacheLOG)"}

}

日期 {

匹配 => {"时间戳"=>"dd/MMM/yyyy:HH:mm:ss Z"}

}

}

输出 {

标准输出 {}

雷迪斯 {

主机="192.168.1.289"

data_type => "列表"

键=>“Logstash”

}

}

几乎在大多数情况下,ELK 同时用作堆栈。在您的数据系统使用 ElasticSearch 的情况下,Logstash 是首选。

4 楚夸

Chukwa 是 Apache 旗下的另一个开源数据采集平台,知名度远不如其他平台。Chukwa 建立在 Hadoop 的 HDFS 和 MapReduce(用 Java 实现)之上,以提供可扩展性和可靠性。它提供了许多模块来支持 Hadoop 集群日志分析。Chukwa 还提供数据展示、分析和监控。该项目目前处于非活动状态。

Chukwa 满足以下需求:

(1)灵活、动态可控的数据源。

(2)高性能、高度可扩展的存储系统。

(3)用于分析采集的大规模数据的适当架构。

Chukwa 架构如图 4 所示。

图 4 Chukwa 架构

5 抄写员

Scribe 是 Facebook 开发的数据(日志)采集系统。其官网多年未维护。Scribe 为日志的“分布式采集、统一处理”提供了可扩展和容错的解决方案。当中央存储系统的网络或机器出现故障时,Scribe 会将日志转储到本地或其他位置;当中央存储系统恢复时,Scribe 会将转储的日志重新传输到中央存储系统。Scribe 通常与 Hadoop 结合使用,将日志推送(push)到 HDFS 中,由 MapReduce 作业定期处理。

Scribe 架构如图 5 所示。

图 5 Scribe 架构

Scribe 架构比较简单,主要包括三个部分,即 Scribe 代理、Scribe 和存储系统。

6 斯普伦克

在商用大数据平台产品中,Splunk提供完整的数据采集、数据存储、数据分析处理、数据呈现能力。Splunk 是一个分布式机器数据平台,具有三个主要角色。Splunk 架构如图 6 所示。

图 6 Splunk 架构

搜索:负责数据的搜索和处理,在搜索过程中提供信息提取功能。

Indexer:负责数据的存储和索引。

Forwarder:负责数据的采集、清洗、变形、发送到Indexer。

Splunk 内置了对 Syslog、TCP/UDP 和 Spooling 的支持。同时,用户可以通过开发 Input 和 Modular Input 来获取特定的数据。Splunk提供的软件仓库中有很多成熟的数据采集应用,比如AWS、数据库(DBConnect)等,可以很方便的从云端或者数据库中获取数据,输入到Splunk数据平台进行分析。

Search Head和Indexer都支持Cluster配置,即高可用和高扩展,但是Splunk还没有Forwarder的Cluster功能。也就是说,如果一台Forwarder机器出现故障,数据采集将中断,正在运行的数据采集任务无法故障转移到其他Forwarder。

7 刮擦

Python 的爬虫架构称为 Scrapy。Scrapy 是一个用 Python 语言开发的快速、高级的屏幕抓取和网页抓取框架,用于抓取网站并从页面中提取结构化数据。Scrapy 用途广泛,可用于数据挖掘、监控和自动化测试。

Scrapy 的吸引力在于它是一种任何人都可以根据需要轻松修改的架构。还提供了各类爬虫的基类,如BaseSpider、Sitemap爬虫等。最新版本提供了对Web2.0爬虫的支持。

Scrapy的工作原理如图7所示。

图 7 Scrapy 运行原理

Scrapy 的整个数据处理流程由 Scrapy 引擎控制。Scrapy运行过程如下:

(1)当Scrapy引擎打开一个域名时,爬虫对域名进行处理,让爬虫获取第一个爬取的URL。

(2)Scrapy引擎首先从爬虫中获取第一个需要爬取的URL,然后在调度中将其作为请求调度。

(3)Scrapy 引擎从调度程序获取要抓取的下一页。

(4)Schedule将下一次爬取的URL返回给引擎,引擎通过下载中间件发送给下载器。

(5)下载器下载网页时,通过下载器中间件将响应内容发送给Scrapy引擎。

(6)Scrapy引擎接收到下载器的响应,通过爬虫中间件发送给爬虫进行处理。

(7)爬虫处理响应并返回爬取的项目,然后向Scrapy引擎发送新的请求。

(8)Scrapy 引擎将抓取的项目放入项目管道并向调度程序发送请求。

(9)系统重复(2)步骤之后的操作,直到调度器中没有请求,然后断开Scrapy引擎与域的连接。

采集工具(文章采集怎么才会让网站快速收录以及关键词排名? )

采集交流 • 优采云 发表了文章 • 0 个评论 • 112 次浏览 • 2022-03-03 19:15

)

文章采集如何让网站快速收录和关键词排名?在大多数学习者看来,所谓的SEO就是把想要的关键词可以优化到首页,但真正的SEO是搜索引擎优化,而不是搜索排名优化。正是因为排名被视为SEO的全部,没有人整天关心排名,导致很多人半途而废;简单来说,你对SEO的了解取决于你在SEO这条路上能走多远,但这无关紧要。正是因为你知道的不多,所以你需要学习!

一、真正的SEO指的是“优化”二字,不仅仅是搜索引擎排名的优化,还有网站浏览体验的优化,网站转化率优化,网站内容质量优化、网站服务器优化、网站设计页面美学优化等等,你有没有发现只知道排名,其他什么都不知道?

接下来教大家如何使用文章采集工具实现采集伪原创自动发布和主动推送到搜索引擎。操作简单,无需学习更多专业技术。只需几个简单的步骤即可轻松采集内容数据,用户只需根据用户设置在文章采集、文章采集工具上进行简单设置< @关键词准确采集文章,保证文章与行业一致。采集中的采集文章可以选择保存在本地,也可以选择自动伪原创发布,提供方便快捷的内容采集和快速的内容创建伪原创。

<p>和其他的文章采集这个wordpres文章采集相比,基本没有什么规则,更别说花很多时间学习正则表达式或者html标签了,直接输入 查看全部

采集工具(文章采集怎么才会让网站快速收录以及关键词排名?

)

文章采集如何让网站快速收录和关键词排名?在大多数学习者看来,所谓的SEO就是把想要的关键词可以优化到首页,但真正的SEO是搜索引擎优化,而不是搜索排名优化。正是因为排名被视为SEO的全部,没有人整天关心排名,导致很多人半途而废;简单来说,你对SEO的了解取决于你在SEO这条路上能走多远,但这无关紧要。正是因为你知道的不多,所以你需要学习!

一、真正的SEO指的是“优化”二字,不仅仅是搜索引擎排名的优化,还有网站浏览体验的优化,网站转化率优化,网站内容质量优化、网站服务器优化、网站设计页面美学优化等等,你有没有发现只知道排名,其他什么都不知道?

接下来教大家如何使用文章采集工具实现采集伪原创自动发布和主动推送到搜索引擎。操作简单,无需学习更多专业技术。只需几个简单的步骤即可轻松采集内容数据,用户只需根据用户设置在文章采集、文章采集工具上进行简单设置< @关键词准确采集文章,保证文章与行业一致。采集中的采集文章可以选择保存在本地,也可以选择自动伪原创发布,提供方便快捷的内容采集和快速的内容创建伪原创。

<p>和其他的文章采集这个wordpres文章采集相比,基本没有什么规则,更别说花很多时间学习正则表达式或者html标签了,直接输入

采集工具(SQLdiag是一个收集SQLServer实例诊断数据的多用途实用工具)

采集交流 • 优采云 发表了文章 • 0 个评论 • 97 次浏览 • 2022-02-24 16:11

SQLdiag 是一个多用途实用程序,可采集有关 SQL Server 实例的诊断数据,并可作为控制台应用程序或服务运行。SQLdiag 可以帮助您采集 SQL Server Profiler 跟踪、Windows 性能监视器日志,并通过配置管理器的可扩展接口输出各种 VBScript、T-SQL 和 DOS 脚本。SQLdiag 采集的数据可以通过 SQL Nexus 导入 SQL Server 数据库,SQL Nexus 是一种 GUI 工具,以报告格式提供采集数据的聚合视图。

SQLdiag 是一个命令行实用程序,默认为 C:\Program Files\Microsoft SQL Server\110\Tools\Binn。您可以在 3 种模式下运行 SQLdiag:

在快照模式下使用 SQLdiag

当 SQLdiag 在快照模式下运行时,它会采集所有已配置诊断数据的快照,然后自动关闭。如果在命令提示符窗口中执行 SQLDIAG /X,SQLdiag 将在 Binn 文件夹中创建一个 SQLDIAG 文件夹,其中收录所有采集的数据。您还将找到一个“内部”文件夹,其中收录该工具创建的日志文件,以及用于在其他文件中采集数据的 XML 配置文件。当您想要快速获取 SQL Server 实例状态的快照时,这种采集数据的方法很有用。您将获得过多的 SQL Server 和 Windows 配置信息、最近遇到的错误、数据库引擎经历的等待等等。数据采集完成后,该工具会自动关闭并显示消息“SQLDIAG 采集完成。

将 SQLdiag 用作命令行应用程序

在查看 SQLdiag 数据采集 之前,您应该先了解 SQLdiag 配置文件,以便正确配置不同的数据采集器。图 11-1 显示了 SQLDIAG.XML 配置文件的关键元素的屏幕截图:

SQLdiag 配置文件关键元素

您可以通过 XML 模板控制 SQLdiag 的采集器。每个 采集器 都可以使用或启用或禁用。不要删除 XML 文件中的采集器,因为如果 XML 文件不匹配,SQLdiag 将无法加载 XSD。如果您想了解 CustomDiagnostics 变量的内部情况,稍后将在“使用 SQLdiag 配置管理器”中进行介绍。以下代码显示了 SQLdiag 可以接受的所有参数:

用法:sqldiag [开始 | 停止 | STOP_ABORT] [/O 输出路径] [/I cfgfile] [/M machine1

[machine2 machineN]|@machinelistfile] [/Q] [/C#] [/G] [/R] [/U] [/N#] [/A appname]

[/T {tcp[,port]|np|lpc|via}] [/X] [/L] [/B YYYYMMDD_HH:MM:SS] [/E YYYYMMDD_HH:MM:SS]

现在让我们看看这些参数是如何使用的,以及一些防止 data采集 成为性能下降的帮凶的最佳实践。

SQLdiag 参数列表

这里有 2 个例子:

SQLDIAG /OD:\SQLDIAG_Data\ /G /B 20121225_00:01:00 /E +02:00:00 ------------ 告诉 SQLdiag 在 20121225_00:01:00 开始采集,2 小时稍后终止,并指定输出路径,/G会跳过连接检查,命令提示窗口会显示“SQLDIAG Begin time 20121225_00:01:00 specified.Waiting”,说明SQLdiag初始化成功。

SQLDIAG /OD:\SQLDIAG_Data\ /A DemoDiag /Q /ID:\SQLDIAG_Custom.xml---------------指示SQLdiag使用配置文件采集数据,使用文件压缩,应用程序名称display 对于DemoDiag,在静默模式下运行,SQLdiag初始化成功后会显示如下信息:

DIAG$DemoDiag 采集器版本

重要提示:请等到您看到“采集已开始”,然后再尝试

重现您的问题

SQLdiag 控制台输出和详细日志可以在输出路径的内部文件夹中找到,分别对应于文件##console.log 和##SQLDIAG.LOG。当工具失败或未能按预期执行时,这两个文件可以提供有关其失败原因的更多信息。不要使用命令提示符窗口的关闭按钮来停止 data采集 进程,因为这会导致 Profiler 跟踪或 PerfMon 文件成为孤立文件。可以使用命令 sp_trace_setstatus 停止探查器跟踪。

将 SQLdiag 用作服务

您可以使用 /R 参数将工具注册为服务,使用 /U 取消注册服务,使用 /A 将 SQLdiag 注册为具有唯一名称的服务。以下命令将 SQLdiag 注册为名为 DIAG1 的服务: SQLDIAG /R /A DIAG1

图 11-2 显示了注册为服务的属性。使用 /A 参数时,服务名称以 DIAG$ 为前缀;如果只使用/R,则服务名为SQLDIAG,如图11-3所示。

请注意,服务注册是使用本地系统的登录帐户完成的,您需要将服务帐户更改为具有 Windows 管理员权限和 SQL Server 实例系统管理员权限的帐户。接下来,有必要决定要指定哪些参数。在以下示例中,SQLdiag 被注册为服务:

'C:\Program Files\Microsoft SQL Server\110\Tools\Binn\sqldiag.exe' /R /IC:\SQLDIAG_Data\SQLDIAG_Custom.XML /O 'C:\SQLDIAG_Data'

成功的服务注册将报告消息“SQLDIAG 服务已安装。退出”。在Windows Application Event Log中可以看到SQLdiag服务报告,如图11-4所示:

在故障转移群集上配置和执行 SQLdiag

使用 Diag Manager 为 SQL Server FCI(故障转移群集实例)配置数据采集 包时,需要牢记以下几点:

在多实例故障转移集群上使用默认配置执行 SQLdiag 时,命令窗口会显示大量错误标记为红色。这是因为默认配置文件 SQLDIAG.XML 尚未更改为来自特定 FCI 的 采集data。SQLdiag 自动发现集群并从每个虚拟机和实例中采集日志和配置信息。该错误显示在命令窗口中,因为 SQLdiag 尝试连接到每个虚拟机上的每个实例,这反过来又失败了多次。在这种情况下,请使用所需的目标虚拟机名称配置 SQLDIAG.XML,或者忽略该错误。可以安全忽略的错误通常可以通过日志文件 (##SQLDIAG.LOG) 来识别。一些可忽略的消息实际上有“短信” 查看全部

采集工具(SQLdiag是一个收集SQLServer实例诊断数据的多用途实用工具)

SQLdiag 是一个多用途实用程序,可采集有关 SQL Server 实例的诊断数据,并可作为控制台应用程序或服务运行。SQLdiag 可以帮助您采集 SQL Server Profiler 跟踪、Windows 性能监视器日志,并通过配置管理器的可扩展接口输出各种 VBScript、T-SQL 和 DOS 脚本。SQLdiag 采集的数据可以通过 SQL Nexus 导入 SQL Server 数据库,SQL Nexus 是一种 GUI 工具,以报告格式提供采集数据的聚合视图。

SQLdiag 是一个命令行实用程序,默认为 C:\Program Files\Microsoft SQL Server\110\Tools\Binn。您可以在 3 种模式下运行 SQLdiag:

在快照模式下使用 SQLdiag

当 SQLdiag 在快照模式下运行时,它会采集所有已配置诊断数据的快照,然后自动关闭。如果在命令提示符窗口中执行 SQLDIAG /X,SQLdiag 将在 Binn 文件夹中创建一个 SQLDIAG 文件夹,其中收录所有采集的数据。您还将找到一个“内部”文件夹,其中收录该工具创建的日志文件,以及用于在其他文件中采集数据的 XML 配置文件。当您想要快速获取 SQL Server 实例状态的快照时,这种采集数据的方法很有用。您将获得过多的 SQL Server 和 Windows 配置信息、最近遇到的错误、数据库引擎经历的等待等等。数据采集完成后,该工具会自动关闭并显示消息“SQLDIAG 采集完成。

将 SQLdiag 用作命令行应用程序

在查看 SQLdiag 数据采集 之前,您应该先了解 SQLdiag 配置文件,以便正确配置不同的数据采集器。图 11-1 显示了 SQLDIAG.XML 配置文件的关键元素的屏幕截图:

SQLdiag 配置文件关键元素

您可以通过 XML 模板控制 SQLdiag 的采集器。每个 采集器 都可以使用或启用或禁用。不要删除 XML 文件中的采集器,因为如果 XML 文件不匹配,SQLdiag 将无法加载 XSD。如果您想了解 CustomDiagnostics 变量的内部情况,稍后将在“使用 SQLdiag 配置管理器”中进行介绍。以下代码显示了 SQLdiag 可以接受的所有参数:

用法:sqldiag [开始 | 停止 | STOP_ABORT] [/O 输出路径] [/I cfgfile] [/M machine1

[machine2 machineN]|@machinelistfile] [/Q] [/C#] [/G] [/R] [/U] [/N#] [/A appname]

[/T {tcp[,port]|np|lpc|via}] [/X] [/L] [/B YYYYMMDD_HH:MM:SS] [/E YYYYMMDD_HH:MM:SS]

现在让我们看看这些参数是如何使用的,以及一些防止 data采集 成为性能下降的帮凶的最佳实践。

SQLdiag 参数列表

这里有 2 个例子:

SQLDIAG /OD:\SQLDIAG_Data\ /G /B 20121225_00:01:00 /E +02:00:00 ------------ 告诉 SQLdiag 在 20121225_00:01:00 开始采集,2 小时稍后终止,并指定输出路径,/G会跳过连接检查,命令提示窗口会显示“SQLDIAG Begin time 20121225_00:01:00 specified.Waiting”,说明SQLdiag初始化成功。

SQLDIAG /OD:\SQLDIAG_Data\ /A DemoDiag /Q /ID:\SQLDIAG_Custom.xml---------------指示SQLdiag使用配置文件采集数据,使用文件压缩,应用程序名称display 对于DemoDiag,在静默模式下运行,SQLdiag初始化成功后会显示如下信息:

DIAG$DemoDiag 采集器版本

重要提示:请等到您看到“采集已开始”,然后再尝试

重现您的问题

SQLdiag 控制台输出和详细日志可以在输出路径的内部文件夹中找到,分别对应于文件##console.log 和##SQLDIAG.LOG。当工具失败或未能按预期执行时,这两个文件可以提供有关其失败原因的更多信息。不要使用命令提示符窗口的关闭按钮来停止 data采集 进程,因为这会导致 Profiler 跟踪或 PerfMon 文件成为孤立文件。可以使用命令 sp_trace_setstatus 停止探查器跟踪。

将 SQLdiag 用作服务

您可以使用 /R 参数将工具注册为服务,使用 /U 取消注册服务,使用 /A 将 SQLdiag 注册为具有唯一名称的服务。以下命令将 SQLdiag 注册为名为 DIAG1 的服务: SQLDIAG /R /A DIAG1

图 11-2 显示了注册为服务的属性。使用 /A 参数时,服务名称以 DIAG$ 为前缀;如果只使用/R,则服务名为SQLDIAG,如图11-3所示。

请注意,服务注册是使用本地系统的登录帐户完成的,您需要将服务帐户更改为具有 Windows 管理员权限和 SQL Server 实例系统管理员权限的帐户。接下来,有必要决定要指定哪些参数。在以下示例中,SQLdiag 被注册为服务:

'C:\Program Files\Microsoft SQL Server\110\Tools\Binn\sqldiag.exe' /R /IC:\SQLDIAG_Data\SQLDIAG_Custom.XML /O 'C:\SQLDIAG_Data'

成功的服务注册将报告消息“SQLDIAG 服务已安装。退出”。在Windows Application Event Log中可以看到SQLdiag服务报告,如图11-4所示:

在故障转移群集上配置和执行 SQLdiag

使用 Diag Manager 为 SQL Server FCI(故障转移群集实例)配置数据采集 包时,需要牢记以下几点:

在多实例故障转移集群上使用默认配置执行 SQLdiag 时,命令窗口会显示大量错误标记为红色。这是因为默认配置文件 SQLDIAG.XML 尚未更改为来自特定 FCI 的 采集data。SQLdiag 自动发现集群并从每个虚拟机和实例中采集日志和配置信息。该错误显示在命令窗口中,因为 SQLdiag 尝试连接到每个虚拟机上的每个实例,这反过来又失败了多次。在这种情况下,请使用所需的目标虚拟机名称配置 SQLDIAG.XML,或者忽略该错误。可以安全忽略的错误通常可以通过日志文件 (##SQLDIAG.LOG) 来识别。一些可忽略的消息实际上有“短信”

采集工具(企业找你为网站招聘员工你一定要自己弄明白常见的几种采集方法)

采集交流 • 优采云 发表了文章 • 0 个评论 • 113 次浏览 • 2022-02-22 05:07

采集工具网站招聘是依靠爬虫技术进行的,不同网站采集的方法还是不同的。如果企业找你为网站招聘员工你一定要自己弄明白常见的几种采集方法了。下面我就一一为大家说明下。1,百度百科。百度百科非常受欢迎。你可以使用一个很笨的方法就可以获取目标网站的图片,这比给企业百度展示网站招聘你爬取的图片容易的多。2,你甚至可以爬取一些微信公众号的文章。

通过你获取的文章链接进行解析出来即可。我就不上图了。你自己度娘下就会明白,效果是一样的。3,你甚至可以爬取社区网站的文章,因为大家都喜欢在社区发帖子,而社区的图片都是网上的,如果你可以爬取到,或许你就可以为社区当客服了。这些图片加上你的文案,或许还可以进行打赏呢。4,如果你这种方法做了一些点缀。还可以使用全站生成地址采集器这个工具。

几乎一个爬虫就可以解决几乎所有问题。你可以爬取一些网页的代码。然后进行解析即可。或者你可以爬取一些html,即爬取到所有的html网页。5,如果你想完全自己来定制定向公司招聘名额方案,这可能非常的麻烦。

根据网站提供的链接,比如2013年7月的上海地区互联网招聘信息。最近和国外的一家公司商量,我们一起做了一款软件:优采云,教小白如何快速采集上海的互联网招聘信息,比如同花顺、永乐之类的软件,还是很方便的。如果你不会做采集工具,就算你会爬虫,也不会做编程,那就难了。 查看全部

采集工具(企业找你为网站招聘员工你一定要自己弄明白常见的几种采集方法)

采集工具网站招聘是依靠爬虫技术进行的,不同网站采集的方法还是不同的。如果企业找你为网站招聘员工你一定要自己弄明白常见的几种采集方法了。下面我就一一为大家说明下。1,百度百科。百度百科非常受欢迎。你可以使用一个很笨的方法就可以获取目标网站的图片,这比给企业百度展示网站招聘你爬取的图片容易的多。2,你甚至可以爬取一些微信公众号的文章。

通过你获取的文章链接进行解析出来即可。我就不上图了。你自己度娘下就会明白,效果是一样的。3,你甚至可以爬取社区网站的文章,因为大家都喜欢在社区发帖子,而社区的图片都是网上的,如果你可以爬取到,或许你就可以为社区当客服了。这些图片加上你的文案,或许还可以进行打赏呢。4,如果你这种方法做了一些点缀。还可以使用全站生成地址采集器这个工具。

几乎一个爬虫就可以解决几乎所有问题。你可以爬取一些网页的代码。然后进行解析即可。或者你可以爬取一些html,即爬取到所有的html网页。5,如果你想完全自己来定制定向公司招聘名额方案,这可能非常的麻烦。

根据网站提供的链接,比如2013年7月的上海地区互联网招聘信息。最近和国外的一家公司商量,我们一起做了一款软件:优采云,教小白如何快速采集上海的互联网招聘信息,比如同花顺、永乐之类的软件,还是很方便的。如果你不会做采集工具,就算你会爬虫,也不会做编程,那就难了。

采集工具(3个非常不错的数据采集工具,轻松采集Windows平台)

采集交流 • 优采云 发表了文章 • 0 个评论 • 294 次浏览 • 2022-04-20 12:55

这里有三个非常好的数据采集工具,分别是优采云织梦采集rules、优采云和优采云,对于大部分网页数据,这三个软件都可以轻松采集,而且不需要写一行代码,操作简单,易学,有兴趣的朋友可以试试:

01优采云采集器1.这是一个非常好的爬虫数据采集工具,在业界非常流行,对个人用户完全免费,整合来自采集织梦采集从规则、处理、分析到挖掘的全流程,可以灵活采集任意网页数据,如果下载了,可以直接从官网,目前只支持Windows平台,依赖.NET4平台:

2.安装完成后打开软件,然后我们就可以直接开始数据爬取了,新建采集任务,设置采集规则,按照提示操作一步步。去吧,官方自带入门教程,非常适合初学者学习使用织梦采集规则:

02优采云采集器1.这是一个很适合小白的数据采集工具织梦采集规则,目前支持3各大主流运营平台,完全免费供个人使用。基于人工智能技术,可自动识别网页中的数据,包括列表、链接、图片等,并支持数据导出和自动翻页功能。如果下载的话,可以直接从官网下载。如下,选择适合你平台的版本:

2.安装完成后打开软件,然后我们可以直接输入URL启动数据采集,这里软件会尝试采集所有可识别的数据供用户选择和过滤,非常智能方便织梦采集规则:

03优采云采集器1.这也是一款非常不错的国产资料采集工具,目前只支持Windows平台,个人使用完全免费,基本功能并且使用方法和前面两个软件类似。您可以通过简单的点击和选择轻松地采集任何网页。如果下载了,也可以直接从官网下载。 exe安装包,双击安装:

2.安装完成后打开软件,然后选择采集方法,可以直接启动数据采集,这里官方也自带现成的数据采集模板,可以轻松采集天猫、京东等网页数据,很不错:

目前,让我们分享这3个很好的数据采集工具。对于大多数网页数据,它可以很容易地采集。只要熟悉使用流程,就能很快掌握,当然,如果熟悉编程,有一定的编程基础,也可以直接使用Python,更加方便灵活网上也有相关的教程和资料。介绍很详细。如果你有兴趣,你可以搜索一下。希望以上分享的内容对大家有帮助,也欢迎大家评论留言补充。

如何获取商店产品?用什么软件来爬取产品?

如何获取商店产品?问题应该是关于data采集软件,它会自动捕获产品信息并保存在本地。这里有3个非常好的数据采集软件,分别是优采云采集器、优采云采集器和优采云采集器,你可以不用写一行代码就可以抓取任何网页信息,感兴趣的朋友可以试试:

国产好用的数据采集软件:优采云采集器这是一款纯国产的数据采集软件,相信很多朋友都听说过或者用过,目前支持自定义采集和简单采集两种方式,鼠标选中需要采集的标签或属性,定义采集规则,软件会自动启动采集进程,支持本地采集和云端采集,采集后的数据可以直接导出到csv、excel或者mysql,方便使用也很方便,而且官方自带很多采集@采集模板可以很方便地采集某宝、某东等热门网站,获取产品信息采集@ >,可以说更合适了:

简单智能数据采集软件:优采云采集器这是一款非常智能非常适合的数据采集软件,基于人工智能技术,可以自动识别采集的标签或属性为必填项,只需输入网页地址,软件会自动启动采集进程,支持自动翻页和数据导出功能(excel、mysql等) ,简单实用,无需配置任何规则,如果只想要纯采集产品信息,不懂代码,不懂编程,可以使用优采云采集器,可以快速上手,非常容易掌握:

专业强大的数据采集软件:优采云采集器这是一个非常高效的数据采集软件,相信很多朋友都听说过,它自动整合来自优采云和优采云采集器的数据,采集的整个流程,清洗、处理、处理,规则更灵活,功能更强大。可能不太容易掌握,但是熟悉了之后,确实是一把数据采集的利器。对于产品信息采集,可以说是绰绰有余了。同时官方还附送了非常详细的入门教程和教学实例,小白学习起来也很轻松:

目前分享这3款好数据采集软件,爬取产品信息完全够用,只要熟悉操作流程,多练习几次,很快就能掌握高手,当然,如果你熟悉网络爬虫并且会编程,你也可以使用python或java。网上也有相关的教程和资料。介绍很详细。如果你有兴趣,你可以搜索一下。我希望上面分享的内容对你有用。请随时添加评论和评论。 查看全部

采集工具(3个非常不错的数据采集工具,轻松采集Windows平台)

这里有三个非常好的数据采集工具,分别是优采云织梦采集rules、优采云和优采云,对于大部分网页数据,这三个软件都可以轻松采集,而且不需要写一行代码,操作简单,易学,有兴趣的朋友可以试试:

01优采云采集器1.这是一个非常好的爬虫数据采集工具,在业界非常流行,对个人用户完全免费,整合来自采集织梦采集从规则、处理、分析到挖掘的全流程,可以灵活采集任意网页数据,如果下载了,可以直接从官网,目前只支持Windows平台,依赖.NET4平台:

2.安装完成后打开软件,然后我们就可以直接开始数据爬取了,新建采集任务,设置采集规则,按照提示操作一步步。去吧,官方自带入门教程,非常适合初学者学习使用织梦采集规则:

02优采云采集器1.这是一个很适合小白的数据采集工具织梦采集规则,目前支持3各大主流运营平台,完全免费供个人使用。基于人工智能技术,可自动识别网页中的数据,包括列表、链接、图片等,并支持数据导出和自动翻页功能。如果下载的话,可以直接从官网下载。如下,选择适合你平台的版本:

2.安装完成后打开软件,然后我们可以直接输入URL启动数据采集,这里软件会尝试采集所有可识别的数据供用户选择和过滤,非常智能方便织梦采集规则:

03优采云采集器1.这也是一款非常不错的国产资料采集工具,目前只支持Windows平台,个人使用完全免费,基本功能并且使用方法和前面两个软件类似。您可以通过简单的点击和选择轻松地采集任何网页。如果下载了,也可以直接从官网下载。 exe安装包,双击安装:

2.安装完成后打开软件,然后选择采集方法,可以直接启动数据采集,这里官方也自带现成的数据采集模板,可以轻松采集天猫、京东等网页数据,很不错:

目前,让我们分享这3个很好的数据采集工具。对于大多数网页数据,它可以很容易地采集。只要熟悉使用流程,就能很快掌握,当然,如果熟悉编程,有一定的编程基础,也可以直接使用Python,更加方便灵活网上也有相关的教程和资料。介绍很详细。如果你有兴趣,你可以搜索一下。希望以上分享的内容对大家有帮助,也欢迎大家评论留言补充。

如何获取商店产品?用什么软件来爬取产品?

如何获取商店产品?问题应该是关于data采集软件,它会自动捕获产品信息并保存在本地。这里有3个非常好的数据采集软件,分别是优采云采集器、优采云采集器和优采云采集器,你可以不用写一行代码就可以抓取任何网页信息,感兴趣的朋友可以试试:

国产好用的数据采集软件:优采云采集器这是一款纯国产的数据采集软件,相信很多朋友都听说过或者用过,目前支持自定义采集和简单采集两种方式,鼠标选中需要采集的标签或属性,定义采集规则,软件会自动启动采集进程,支持本地采集和云端采集,采集后的数据可以直接导出到csv、excel或者mysql,方便使用也很方便,而且官方自带很多采集@采集模板可以很方便地采集某宝、某东等热门网站,获取产品信息采集@ >,可以说更合适了:

简单智能数据采集软件:优采云采集器这是一款非常智能非常适合的数据采集软件,基于人工智能技术,可以自动识别采集的标签或属性为必填项,只需输入网页地址,软件会自动启动采集进程,支持自动翻页和数据导出功能(excel、mysql等) ,简单实用,无需配置任何规则,如果只想要纯采集产品信息,不懂代码,不懂编程,可以使用优采云采集器,可以快速上手,非常容易掌握:

专业强大的数据采集软件:优采云采集器这是一个非常高效的数据采集软件,相信很多朋友都听说过,它自动整合来自优采云和优采云采集器的数据,采集的整个流程,清洗、处理、处理,规则更灵活,功能更强大。可能不太容易掌握,但是熟悉了之后,确实是一把数据采集的利器。对于产品信息采集,可以说是绰绰有余了。同时官方还附送了非常详细的入门教程和教学实例,小白学习起来也很轻松:

目前分享这3款好数据采集软件,爬取产品信息完全够用,只要熟悉操作流程,多练习几次,很快就能掌握高手,当然,如果你熟悉网络爬虫并且会编程,你也可以使用python或java。网上也有相关的教程和资料。介绍很详细。如果你有兴趣,你可以搜索一下。我希望上面分享的内容对你有用。请随时添加评论和评论。

采集工具(一下常用的数据采集工具-一下日志采集框架与工具)

采集交流 • 优采云 发表了文章 • 0 个评论 • 212 次浏览 • 2022-04-15 20:12

随着大数据技术体系的发展,越来越多的企业利用大数据技术来支持其业务发展。数据采集作为大数据的起点,是企业主动获取数据的重要手段。数据采集的多样性和全面性直接影响数据质量。

企业获取数据的渠道分为内部渠道和外部渠道两种。内部渠道包括自建业务系统,如电商系统、门户网站网站、门户论坛等。外部渠道包括爬虫系统爬取的数据、三方合作平台的数据、公众的数据社交平台。那么如何从这些来源获取数据呢?下面简单介绍一下常用的data采集工具。

结构化数据采集工具。

结构化数据占分析原创数据的很大一部分,其中大部分被预处理到数据仓库中,以进行进一步的多维分析和数据挖掘。常用的数据采集工具有:

1 阿帕奇水槽

支持离线和实时数据导入,是数据集成的主要工具。

2 Apache Sqoop

主要使用JDBC等工具连接关系型数据库和Hadoop生态系统的文件系统。通过配置文件配置双向连接信息后,通过命令完成数据的导入导出。

半结构化数据采集工具

半结构化数据在日志格式中更为常见。对于记录 采集 的工具,更常见的是

1个Logstash

Logstash 与 ElasticSearch 和 Kibana 并称为 ELK,是 采集 日志的黄金搭档。

2 Apache Flume 也主要用于日志文本数据采集。

非结构化数据采集工具

1 数据X

DataX 是一个轻量级的中间件,在关系型数据库中具有出色的导入导出性能。支持多种数据类型的导入导出。

流数据采集工具

1 卡夫卡

卓越的性能和超高的吞吐量。

Binlog日志采集工具

1 运河

基于MySQL数据库的增量日志分析提供增量日志订阅和消费功能。

爬虫采集框架和工具

1 Java 堆栈、Nutch2、WebMagic 等。

2 Python 堆栈、Scrapy、PySpider

3 第三方爬虫工具,优采云、优采云、优采云等。 查看全部

采集工具(一下常用的数据采集工具-一下日志采集框架与工具)

随着大数据技术体系的发展,越来越多的企业利用大数据技术来支持其业务发展。数据采集作为大数据的起点,是企业主动获取数据的重要手段。数据采集的多样性和全面性直接影响数据质量。

企业获取数据的渠道分为内部渠道和外部渠道两种。内部渠道包括自建业务系统,如电商系统、门户网站网站、门户论坛等。外部渠道包括爬虫系统爬取的数据、三方合作平台的数据、公众的数据社交平台。那么如何从这些来源获取数据呢?下面简单介绍一下常用的data采集工具。

结构化数据采集工具。

结构化数据占分析原创数据的很大一部分,其中大部分被预处理到数据仓库中,以进行进一步的多维分析和数据挖掘。常用的数据采集工具有:

1 阿帕奇水槽

支持离线和实时数据导入,是数据集成的主要工具。

2 Apache Sqoop

主要使用JDBC等工具连接关系型数据库和Hadoop生态系统的文件系统。通过配置文件配置双向连接信息后,通过命令完成数据的导入导出。

半结构化数据采集工具

半结构化数据在日志格式中更为常见。对于记录 采集 的工具,更常见的是

1个Logstash

Logstash 与 ElasticSearch 和 Kibana 并称为 ELK,是 采集 日志的黄金搭档。

2 Apache Flume 也主要用于日志文本数据采集。

非结构化数据采集工具

1 数据X

DataX 是一个轻量级的中间件,在关系型数据库中具有出色的导入导出性能。支持多种数据类型的导入导出。

流数据采集工具

1 卡夫卡

卓越的性能和超高的吞吐量。

Binlog日志采集工具

1 运河

基于MySQL数据库的增量日志分析提供增量日志订阅和消费功能。

爬虫采集框架和工具

1 Java 堆栈、Nutch2、WebMagic 等。

2 Python 堆栈、Scrapy、PySpider

3 第三方爬虫工具,优采云、优采云、优采云等。

采集工具(全网彩票采集工具的详细介绍及解决办法!!)

采集交流 • 优采云 发表了文章 • 0 个评论 • 390 次浏览 • 2022-04-15 04:02

采集工具

一、1688采集工具

1、1688全网车辆采集

2、1688全网厨房采集

3、1688产品采集导出工具

4、全网彩票采集

二、长尾关键词采集工具

1、长尾关键词采集

2、词频分析

3、采集长尾关键词采集

4、长尾关键词长尾关键词分析

5、长尾关键词词频分析

三、买家店铺店铺采集工具

1、商品采集宝贝批量采集

2、商品采集宝贝多店铺采集

3、店铺采集

四、短视频平台商品采集工具

五、价格公式电器类的采集

1、价格公式-打印机采集

2、价格公式-打印机采集

3、打印机租赁

4、打印机租赁

5、打印机电源

6、打印机电源

6、打印机租赁

八、百度网盘

1、直接在百度网盘搜索框搜索,有人分享的百度网盘资源,

三、采集工具

1、在采集软件比较多,如易点云采集器,还有很多。

2、直接在搜索框搜索后,有人分享的采集工具。

3、直接在搜索框搜索后,有人分享的采集工具。

4、直接在搜索框搜索后,有人分享的采集工具。

5、直接在搜索框搜索后,有人分享的采集工具。

这位同学很有想法,我的想法是大家做的话肯定是先用软件做用户,不会用户或者体验不好再用网站。我刚看过市面上的其他软件,有的实现这一点有的没实现,或者体验好的却来自于搞个网站偷偷增加收费。那么剩下的方案就是自己做用户,有了关注量和使用习惯了再去搞网站,加上上面@黄天日已经说的需求采集工具,最后导入原有网站。 查看全部

采集工具(全网彩票采集工具的详细介绍及解决办法!!)

采集工具

一、1688采集工具

1、1688全网车辆采集

2、1688全网厨房采集

3、1688产品采集导出工具

4、全网彩票采集

二、长尾关键词采集工具

1、长尾关键词采集

2、词频分析

3、采集长尾关键词采集

4、长尾关键词长尾关键词分析

5、长尾关键词词频分析

三、买家店铺店铺采集工具

1、商品采集宝贝批量采集

2、商品采集宝贝多店铺采集

3、店铺采集

四、短视频平台商品采集工具

五、价格公式电器类的采集

1、价格公式-打印机采集

2、价格公式-打印机采集

3、打印机租赁

4、打印机租赁

5、打印机电源

6、打印机电源

6、打印机租赁

八、百度网盘

1、直接在百度网盘搜索框搜索,有人分享的百度网盘资源,

三、采集工具

1、在采集软件比较多,如易点云采集器,还有很多。

2、直接在搜索框搜索后,有人分享的采集工具。

3、直接在搜索框搜索后,有人分享的采集工具。

4、直接在搜索框搜索后,有人分享的采集工具。

5、直接在搜索框搜索后,有人分享的采集工具。

这位同学很有想法,我的想法是大家做的话肯定是先用软件做用户,不会用户或者体验不好再用网站。我刚看过市面上的其他软件,有的实现这一点有的没实现,或者体验好的却来自于搞个网站偷偷增加收费。那么剩下的方案就是自己做用户,有了关注量和使用习惯了再去搞网站,加上上面@黄天日已经说的需求采集工具,最后导入原有网站。

采集工具(人社部政府特殊津贴个人信息采集工具使用说明注说明书)

采集交流 • 优采云 发表了文章 • 0 个评论 • 181 次浏览 • 2022-04-10 10:08

人才信息采集工具说明 注:以“政府特殊津贴个人采集工具”操作说明为例。附加信息采集工具的操作方式相同。软件下载 国家“高级专业技术人员管理”软件的所有相关个人信息采集均可通过“”官方网站下载。具体下载地址在首页“新闻中心”有相应的指导和说明。软件安装 双击下载的“人社部政府特殊津贴个人信息采集工具”软件(图2-1-1)安装软件。图2-1-1注意:操作系统为Vista \win7\win8的用户可以在运行安装程序前给程序添加兼容性和以管理员身份运行选项,操作方法是在安装程序上右击选择属性弹出界面(如如图2-1-2),选择后点击“确定”按钮完成设置 图2-1-2 双击安装程序,弹出界面如图2- 2-1: 图2-2-1 点击“浏览”选择软件安装路径后,点击“下一步”,如下图2-3-1所示: 图2-3-1 执行附加任务 选择“创建”左侧快捷方式”,点击“下一步”,如下图 2-4-1 图 2-4-1 在“准备安装”过程中点击“安装”进行安装l 电脑上的程序,安装完成后,图2-5-1 图2-5-1 安装程序双击桌面生成软件(图3-1)“人社部政府特殊津贴个人信息采集工具”。

注意:操作系统为Vista\win7\win8的用户可以在运行程序前为程序添加兼容性和以管理员身份运行选项。方法见安装点1。图 3-1 进入软件主界面如下图 3-2 所示: 图 3-2 保存:先“临时保存”数据(即自动备份),然后选择是否验证数据的有效性输入数据,验证成功后,数据“正式保存”。清除:点击清除所有页面数据,不可撤销,请谨慎使用。备份:要备份当前数据(XXX.bak),需要先设置文件存储路径。恢复:用于恢复“备份”时备份的文件(XXX.bak)。生成报告:为通过合法性验证的“官方保存”数据生成报告文件(RPU)。注:点击“生成提交”按钮后,会自动进行“保存”操作,需要申请人输入的数据通过合法性验证。如果不通过,则退出提交操作; ”(图3-3)设置界面,申请人选择文件存储路径并设置文件名,点击确定完成提交操作。RPU文件仅在“信息”采集@ >Tools”或“高级专业技术人员管理”软件,不能通过其他打开方式打开,否则会对文件本身造成不可修复的损坏。 图2-3 接收报告:接收RPU文件 当前个人中的数据信息采集软件。注意:点击“接收提交”按钮后,会弹出一个标题为“打开”的提交文件选择窗口(图2-4),选择要接收的RPU文件,点击好的。

软件中的所有原创数据在接收前都会被自动清除。图2-4 打印:弹出可打印报表列表供参会人员选择预览,可直接在预览界面打印。注:选择报告后,会自动进行“保存”操作,申请人输入的数据需通过合法性验证。如果不通过,则退出打印操作;如果通过,会弹出打印报表的预览界面。帮助:弹出帮助文件供审阅者查看。退出:退出软件,退出前会自动进行数据备份。翻页:对当前条目表进行翻页。注:当可以录入多页内容(论文、奖项等)时,填写当前页后点击下一页,会出现一个新的录入页面(录入说明中还有其他翻页方式) 显示比例:调整当前条目表的显示比例。删除当前行:删除子集数据当前选中行的数据。注意:如果所选数据不可删除,则该按钮将显示为灰色。输入区:显示“输入报表”的整体内容,可以选择报表的“单元格”,然后填写相应的数据内容。导航栏:当前“进入报表”的导航,如果选中对应项,报表将直接翻到对应页面。录入说明:显示当前“录入报表”中选中的“单元格”的录入提示信息。浮栏说明:输入多行内容时出现(图2-5)。图2-5 数据上报人员确认数据填写并核对后,使用“生成报表”功能生成数据文件(XXX.RPU),通过U盘拷贝、Email发送、刻录CD等方式将该文件提交给您的单位(或推荐单位)。

输入报表的注意事项和FAQ首页的“填表时间”是根据保存时间自动生成的,不需要填写。 “工作经历”和“代表作”没有字数限制,但请尽量限制在1000字左右,否则打印时字体会小不美观。 “奖项”的参赛作品数量没有限制。填完一页后,点击翻页按钮中的“下一步”或键盘上的“↓”添加空白页。 “政府特刊”条目表的标题和“专家注册”打印表的标题是相互独立的。报名表只对采集数据负责,不打印,打印时以打印表为准。个人信息报告打印表的纸质格式为B5。如果使用 A4 纸打印,需要在打印选项中选择“按纸张比例打印”和“居中打印”。数据填写完成后点击保存、打印或生成提交,会出现“特帖和特奖违规关键违规”的错误,查看获奖情况下的获奖项目是否重复数据填写完成后,点击保存、打印或生成报告时显示“Photo Key Violation”错误,因为输入了多张照片,点击照片所在位置,然后使用“删除当前行”按钮(或 Ctrl+Delete 组合键))删除照片,直到照片所在位置为空,然后重新导入照片。 “评估”信息内容不能填写在专帖采集工具中。注:更多常见问题请参见个人信息采集工具下载页面。 3、条目导航区2、条目区1、工具栏4、条目描述区删除这条子集记录下一条记录向上移动这条记录 查看全部

采集工具(人社部政府特殊津贴个人信息采集工具使用说明注说明书)

人才信息采集工具说明 注:以“政府特殊津贴个人采集工具”操作说明为例。附加信息采集工具的操作方式相同。软件下载 国家“高级专业技术人员管理”软件的所有相关个人信息采集均可通过“”官方网站下载。具体下载地址在首页“新闻中心”有相应的指导和说明。软件安装 双击下载的“人社部政府特殊津贴个人信息采集工具”软件(图2-1-1)安装软件。图2-1-1注意:操作系统为Vista \win7\win8的用户可以在运行安装程序前给程序添加兼容性和以管理员身份运行选项,操作方法是在安装程序上右击选择属性弹出界面(如如图2-1-2),选择后点击“确定”按钮完成设置 图2-1-2 双击安装程序,弹出界面如图2- 2-1: 图2-2-1 点击“浏览”选择软件安装路径后,点击“下一步”,如下图2-3-1所示: 图2-3-1 执行附加任务 选择“创建”左侧快捷方式”,点击“下一步”,如下图 2-4-1 图 2-4-1 在“准备安装”过程中点击“安装”进行安装l 电脑上的程序,安装完成后,图2-5-1 图2-5-1 安装程序双击桌面生成软件(图3-1)“人社部政府特殊津贴个人信息采集工具”。

注意:操作系统为Vista\win7\win8的用户可以在运行程序前为程序添加兼容性和以管理员身份运行选项。方法见安装点1。图 3-1 进入软件主界面如下图 3-2 所示: 图 3-2 保存:先“临时保存”数据(即自动备份),然后选择是否验证数据的有效性输入数据,验证成功后,数据“正式保存”。清除:点击清除所有页面数据,不可撤销,请谨慎使用。备份:要备份当前数据(XXX.bak),需要先设置文件存储路径。恢复:用于恢复“备份”时备份的文件(XXX.bak)。生成报告:为通过合法性验证的“官方保存”数据生成报告文件(RPU)。注:点击“生成提交”按钮后,会自动进行“保存”操作,需要申请人输入的数据通过合法性验证。如果不通过,则退出提交操作; ”(图3-3)设置界面,申请人选择文件存储路径并设置文件名,点击确定完成提交操作。RPU文件仅在“信息”采集@ >Tools”或“高级专业技术人员管理”软件,不能通过其他打开方式打开,否则会对文件本身造成不可修复的损坏。 图2-3 接收报告:接收RPU文件 当前个人中的数据信息采集软件。注意:点击“接收提交”按钮后,会弹出一个标题为“打开”的提交文件选择窗口(图2-4),选择要接收的RPU文件,点击好的。

软件中的所有原创数据在接收前都会被自动清除。图2-4 打印:弹出可打印报表列表供参会人员选择预览,可直接在预览界面打印。注:选择报告后,会自动进行“保存”操作,申请人输入的数据需通过合法性验证。如果不通过,则退出打印操作;如果通过,会弹出打印报表的预览界面。帮助:弹出帮助文件供审阅者查看。退出:退出软件,退出前会自动进行数据备份。翻页:对当前条目表进行翻页。注:当可以录入多页内容(论文、奖项等)时,填写当前页后点击下一页,会出现一个新的录入页面(录入说明中还有其他翻页方式) 显示比例:调整当前条目表的显示比例。删除当前行:删除子集数据当前选中行的数据。注意:如果所选数据不可删除,则该按钮将显示为灰色。输入区:显示“输入报表”的整体内容,可以选择报表的“单元格”,然后填写相应的数据内容。导航栏:当前“进入报表”的导航,如果选中对应项,报表将直接翻到对应页面。录入说明:显示当前“录入报表”中选中的“单元格”的录入提示信息。浮栏说明:输入多行内容时出现(图2-5)。图2-5 数据上报人员确认数据填写并核对后,使用“生成报表”功能生成数据文件(XXX.RPU),通过U盘拷贝、Email发送、刻录CD等方式将该文件提交给您的单位(或推荐单位)。

输入报表的注意事项和FAQ首页的“填表时间”是根据保存时间自动生成的,不需要填写。 “工作经历”和“代表作”没有字数限制,但请尽量限制在1000字左右,否则打印时字体会小不美观。 “奖项”的参赛作品数量没有限制。填完一页后,点击翻页按钮中的“下一步”或键盘上的“↓”添加空白页。 “政府特刊”条目表的标题和“专家注册”打印表的标题是相互独立的。报名表只对采集数据负责,不打印,打印时以打印表为准。个人信息报告打印表的纸质格式为B5。如果使用 A4 纸打印,需要在打印选项中选择“按纸张比例打印”和“居中打印”。数据填写完成后点击保存、打印或生成提交,会出现“特帖和特奖违规关键违规”的错误,查看获奖情况下的获奖项目是否重复数据填写完成后,点击保存、打印或生成报告时显示“Photo Key Violation”错误,因为输入了多张照片,点击照片所在位置,然后使用“删除当前行”按钮(或 Ctrl+Delete 组合键))删除照片,直到照片所在位置为空,然后重新导入照片。 “评估”信息内容不能填写在专帖采集工具中。注:更多常见问题请参见个人信息采集工具下载页面。 3、条目导航区2、条目区1、工具栏4、条目描述区删除这条子集记录下一条记录向上移动这条记录

采集工具(ET2全自动采集器通过接口发布和模拟发布两种方式,支持任意发布项语言翻译)

采集交流 • 优采云 发表了文章 • 0 个评论 • 110 次浏览 • 2022-04-06 17:27

ET2通过界面发布和仿真发布实现全自动采集器,支持大部分通用或用户开发的网站程序,包括Dedecms在ET@>中预设,Discuz , Dvbbs, Phpwind, 东翼cms@>, Wordpress, Empirecms@>, 风迅Fcms@>, Kingcms@>, Php168、Php< 主流网站程序发布接口如@cms、bbsxp、Phpbb等,用户可以通过制作自己的接口来支持自己专用的网站。

软件功能:

1、设定好计划后,无需人工干预即可24小时自动工作

2、与网站分离,可以支持任何网站或数据库

通过独立制作的界面

3、体积小、功耗低、稳定性好,非常适合在服务器上运行

4、所有规则均可导入导出,资源复用灵活

5、使用FTP上传文件,稳定安全

6、可以选择倒序、顺序、随机采集文章

7、支持自动列出网址

8、支持采集

对于网站的数据分布在多个页面

9、自由设置采集数据项,可以对每个数据项进行单独过滤和组织

10、支持分页内容采集

11、支持任何格式和类型的文件(包括图片、视频)下载

12、突破防盗链文件

13、支持动态文件URL解析

14、支持采集

对于需要登录访问的网页

15、可配置关键词采集

16、可以设置敏感词防止采集

17、可以设置图片水印

18、支持发布文章带回复,可广泛用于论坛、博客等。

19、和采集数据分离发布参数项,可自由对应采集数据或预设值,大大增强发布规则的复用性

20、支持随机选择发布账号

21、支持任何出版语言翻译

22、支持编码转换,支持UBB码

23、文件上传可以选择自动创建年月日目录

24、模拟发布支持网站无法安装接口的发布操作

25、计划可以正常工作

26、防止网络运营商劫持 HTTP 功能

27、手动个人采集已发布

28、详细的工作流程监控和信息反馈,让您快速了解工作状态

更新日志:

V2.5.1 更新:

1、增加:支持随机插入字符串,数据排序见“随机定位标记”;

2、新增:数据排序和参数值现在可以使用“时间戳”来获取当前时间;

3、新增:为数据排序添加“不等式标记”;

4、新增:通过列表分析获得的其他信息现在可以在数据管理中引用;

5、新功能:下载失败的图像代码现在可以自动从 文章 中删除;

6、优化:动态网址的文件扩展名识别更准确;

7、优化:启动自动工作时,可以先处理方案现有目录;

8、优化:数据分页现在上限2000页;

9、修复:解决匹配多个内容时数据项选择第一个空格会导致乱码的问题;

10、修复:自动列表和逻辑分页数字现在支持更长的数字。 查看全部

采集工具(ET2全自动采集器通过接口发布和模拟发布两种方式,支持任意发布项语言翻译)

ET2通过界面发布和仿真发布实现全自动采集器,支持大部分通用或用户开发的网站程序,包括Dedecms在ET@>中预设,Discuz , Dvbbs, Phpwind, 东翼cms@>, Wordpress, Empirecms@>, 风迅Fcms@>, Kingcms@>, Php168、Php< 主流网站程序发布接口如@cms、bbsxp、Phpbb等,用户可以通过制作自己的接口来支持自己专用的网站。

软件功能:

1、设定好计划后,无需人工干预即可24小时自动工作

2、与网站分离,可以支持任何网站或数据库

通过独立制作的界面

3、体积小、功耗低、稳定性好,非常适合在服务器上运行

4、所有规则均可导入导出,资源复用灵活

5、使用FTP上传文件,稳定安全

6、可以选择倒序、顺序、随机采集文章

7、支持自动列出网址

8、支持采集

对于网站的数据分布在多个页面

9、自由设置采集数据项,可以对每个数据项进行单独过滤和组织

10、支持分页内容采集

11、支持任何格式和类型的文件(包括图片、视频)下载

12、突破防盗链文件

13、支持动态文件URL解析

14、支持采集

对于需要登录访问的网页

15、可配置关键词采集

16、可以设置敏感词防止采集

17、可以设置图片水印

18、支持发布文章带回复,可广泛用于论坛、博客等。

19、和采集数据分离发布参数项,可自由对应采集数据或预设值,大大增强发布规则的复用性

20、支持随机选择发布账号

21、支持任何出版语言翻译

22、支持编码转换,支持UBB码

23、文件上传可以选择自动创建年月日目录

24、模拟发布支持网站无法安装接口的发布操作

25、计划可以正常工作

26、防止网络运营商劫持 HTTP 功能

27、手动个人采集已发布

28、详细的工作流程监控和信息反馈,让您快速了解工作状态

更新日志:

V2.5.1 更新:

1、增加:支持随机插入字符串,数据排序见“随机定位标记”;

2、新增:数据排序和参数值现在可以使用“时间戳”来获取当前时间;

3、新增:为数据排序添加“不等式标记”;

4、新增:通过列表分析获得的其他信息现在可以在数据管理中引用;

5、新功能:下载失败的图像代码现在可以自动从 文章 中删除;

6、优化:动态网址的文件扩展名识别更准确;

7、优化:启动自动工作时,可以先处理方案现有目录;

8、优化:数据分页现在上限2000页;

9、修复:解决匹配多个内容时数据项选择第一个空格会导致乱码的问题;

10、修复:自动列表和逻辑分页数字现在支持更长的数字。

采集工具(什么是优采云采集?写作推出智能采集工具写作)

采集交流 • 优采云 发表了文章 • 0 个评论 • 112 次浏览 • 2022-04-05 04:17

疫情期间,不少企业不得不选择在线远程办公。互联网是受疫情影响较小的行业之一,但远程工作的效率一直低于面对面工作。为此,优采云采集推出了智能采集工具。

相信很多运营商都接触过采集工具。现在市场上有各种 采集 工具。很多人认为采集工具只是作为文章热点/节日话题等信息采集的辅助工具,其实不仅如此。一个成熟的采集工具,不仅有利于对采集信息的操作,还能准确分析数据趋势,从而帮助增加收入。

优采云采集 是什么?

优采云采集是自媒体素材搜索、文章原创、一键发布的操作工具,有效提升新媒体运营效率,降低企业成本。

如何使用 优采云采集 进行搜索?

输入 关键词

优采云采集根据用户输入的关键词,通过程序自动搜索进入主流自媒体数据源的搜索引擎。

优采云采集基于高级算法匹配更准确的内容,提高搜索内容的准确性。

例如:

用户需要采集与疫情相关的资料,并在主页面输入关键词“流行病”。优采云采集 会将搜索结果合并到一个列表中。

保存搜索材料

优采云采集具有批量保存搜索素材的功能。

点击【当前页全选】功能,勾选需要的文章,文章会添加到操作面板,方便用户批量保存。

精确过滤

搜索过滤器

优采云采集支持按标题、内容、时间、平台、是否原创等参数进行过滤,使搜索内容更加准确。

广告过滤 查看全部

采集工具(什么是优采云采集?写作推出智能采集工具写作)

疫情期间,不少企业不得不选择在线远程办公。互联网是受疫情影响较小的行业之一,但远程工作的效率一直低于面对面工作。为此,优采云采集推出了智能采集工具。

相信很多运营商都接触过采集工具。现在市场上有各种 采集 工具。很多人认为采集工具只是作为文章热点/节日话题等信息采集的辅助工具,其实不仅如此。一个成熟的采集工具,不仅有利于对采集信息的操作,还能准确分析数据趋势,从而帮助增加收入。

优采云采集 是什么?

优采云采集是自媒体素材搜索、文章原创、一键发布的操作工具,有效提升新媒体运营效率,降低企业成本。

如何使用 优采云采集 进行搜索?

输入 关键词

优采云采集根据用户输入的关键词,通过程序自动搜索进入主流自媒体数据源的搜索引擎。

优采云采集基于高级算法匹配更准确的内容,提高搜索内容的准确性。

例如:

用户需要采集与疫情相关的资料,并在主页面输入关键词“流行病”。优采云采集 会将搜索结果合并到一个列表中。

保存搜索材料

优采云采集具有批量保存搜索素材的功能。

点击【当前页全选】功能,勾选需要的文章,文章会添加到操作面板,方便用户批量保存。

精确过滤

搜索过滤器

优采云采集支持按标题、内容、时间、平台、是否原创等参数进行过滤,使搜索内容更加准确。

广告过滤

采集工具(如何采集国外网站的源代码?这是一个怎样的体验?)

采集交流 • 优采云 发表了文章 • 0 个评论 • 91 次浏览 • 2022-04-03 13:04

采集工具推荐:1.tower:当然你也可以直接采集bootstrap,提供了一套bootstrapv3以及bootstrapv4官方库。2.知乎:同样可以采集或直接从知乎采集源代码或有价值的信息。3.github:利用github也可以很方便的采集项目代码和别人代码,甚至把知乎或github的项目整合到一起。

4.国内镜像站:很多国内镜像站,包括支持知乎的bootstrap代码的搜狐、爱问、维基、网易等。5.国外网站:比如stackoverflow,filezilla、wolframalpha、sams等,当然还有很多国外网站不支持github直接采集代码,但可以用sams/sams-operator搭梯子,方便采集国外网站的源代码。

采集源代码推荐:1.githubpages:不多说,直接上图。2.阿里云存储(keepalived):支持github、百度云以及各种云存储,postgo也支持!!!3./。

使用facebook:/,把你在公司的工作簿都上传到facebook上。按日、周、月的时间顺序,

其实在我做前端的过程中,这类采集代码一开始都是f5采集器之类提供的,针对个人服务那种。如果想学习,

github中有很多,

百度搜索ifttt

有个叫echo技术社区的网站,

程序员_程序员论坛主站的javascript多语言版 查看全部

采集工具(如何采集国外网站的源代码?这是一个怎样的体验?)

采集工具推荐:1.tower:当然你也可以直接采集bootstrap,提供了一套bootstrapv3以及bootstrapv4官方库。2.知乎:同样可以采集或直接从知乎采集源代码或有价值的信息。3.github:利用github也可以很方便的采集项目代码和别人代码,甚至把知乎或github的项目整合到一起。

4.国内镜像站:很多国内镜像站,包括支持知乎的bootstrap代码的搜狐、爱问、维基、网易等。5.国外网站:比如stackoverflow,filezilla、wolframalpha、sams等,当然还有很多国外网站不支持github直接采集代码,但可以用sams/sams-operator搭梯子,方便采集国外网站的源代码。

采集源代码推荐:1.githubpages:不多说,直接上图。2.阿里云存储(keepalived):支持github、百度云以及各种云存储,postgo也支持!!!3./。

使用facebook:/,把你在公司的工作簿都上传到facebook上。按日、周、月的时间顺序,

其实在我做前端的过程中,这类采集代码一开始都是f5采集器之类提供的,针对个人服务那种。如果想学习,

github中有很多,

百度搜索ifttt

有个叫echo技术社区的网站,

程序员_程序员论坛主站的javascript多语言版

采集工具(excel+word+access,为什么没有人推荐一个呢?)

采集交流 • 优采云 发表了文章 • 0 个评论 • 117 次浏览 • 2022-04-03 04:06

采集工具的话,推荐我们的企业微信运营助手,免费使用,一键采集公众号文章,智能标签、标签多渠道关键词采集、公众号文章多渠道搜索,

如果没有特殊需求的话,完全可以看专业的网站推广人员做的网站收集网站,以下是几个有名的收集网站——福布斯富豪榜:bloombergforelitewealth|fortunehorsemagazine(高净值俱乐部):,很全面的收集榜单和大咖列表。

自己挖的坟建了个微信公众号--企业微信引流群,

用excel模板批量采集,word文档随意修改部分,

一,大数据采集二,智能标签抓取三,

工具很多,百度搜一搜都有,我使用过的工具,可以解决好多难题,分享给你。【excel+word+access】一,工具电脑软件【excel+word+access】二,

为什么没有人推荐一个呢

还是excel+word+access,lietome,楼上说的都挺好的。

excel+word+access很不错

word+access+excel

可以上网站搜索这个学习。有道有学好数理化走遍天下都不怕。

可以上网站搜索这个学习

一个网站,36524网,可以注册做个自己的网站。

我做过一个免费的, 查看全部

采集工具(excel+word+access,为什么没有人推荐一个呢?)

采集工具的话,推荐我们的企业微信运营助手,免费使用,一键采集公众号文章,智能标签、标签多渠道关键词采集、公众号文章多渠道搜索,

如果没有特殊需求的话,完全可以看专业的网站推广人员做的网站收集网站,以下是几个有名的收集网站——福布斯富豪榜:bloombergforelitewealth|fortunehorsemagazine(高净值俱乐部):,很全面的收集榜单和大咖列表。

自己挖的坟建了个微信公众号--企业微信引流群,

用excel模板批量采集,word文档随意修改部分,

一,大数据采集二,智能标签抓取三,

工具很多,百度搜一搜都有,我使用过的工具,可以解决好多难题,分享给你。【excel+word+access】一,工具电脑软件【excel+word+access】二,

为什么没有人推荐一个呢

还是excel+word+access,lietome,楼上说的都挺好的。

excel+word+access很不错

word+access+excel

可以上网站搜索这个学习。有道有学好数理化走遍天下都不怕。

可以上网站搜索这个学习

一个网站,36524网,可以注册做个自己的网站。

我做过一个免费的,

采集工具(基于新浪新闻的全网搜索【iLab开发】思路:与第一种方法)

采集交流 • 优采云 发表了文章 • 0 个评论 • 122 次浏览 • 2022-03-30 03:13

这两天一直在帮李老师做采集“GEM”主题相关的网络资料,顺便研究了几个不同的网络资料工具采集,包括两个iLab Lab开发的采集工具和两个网上知名的网络资料采集工具。

一、基于谷歌/百度等搜索引擎的全网搜索[iLab开发]

思路:这种方法的基本原理是使用一个通用的搜索引擎,采集它的检索结果。通常取其搜索结果的前 100 页。源码是通过抓取搜索结果条目的url得到的,通过文本提取算法得到原文。因此,一个通用搜索引擎的所有功能,如多重关键词、现场检索等,都可以在这个工具中体现出来。

优点:搜索结果覆盖范围广。

缺点:如果想采集更具体的话题信息,需要指向垂直专业的站点(site:);搜索引擎返回的结果没有固定格式的模板,很难采集全文,只能使用一般的文本提取算法,目前准确率可以达到75%。

二、基于新浪新闻的全网搜索[iLab开发]

思路:与第一种方法类似,这里是新浪的新闻搜索平台。其索引范围包括新浪自己的新闻和其他网站新闻,全文和标题字段均可搜索。抓取方法同上。

优点:由于数据源为新闻报道,数据结构比较规范,便于提取原文。

缺点:覆盖面不足,针对新闻数据。

经测试,新浪搜索平台在标题字段中检索,主题相关性更强,新浪自有新闻数据保存较好。因此,我们的工具选择了采集“新浪新闻+标题”的检索方式得到的结果。

三、优采云

很早以前就听说过这个采集工具,但是前两天实际使用的时候,发现它的功能真的很强大。几乎任何浏览器都可以访问信息采集,还集成了分词等功能。在做多级链接采集和分页采集的时候也很方便。网上有免费版可供下载,商业版功能和售后服务更完善。

思路:优采云采集的基本思路是url采集+内容模板设置。它还提供全面的数据保存和发布功能。

优点:可以是 采集 特定的网站 和板;完全符合。

缺点:了解了它的所有特性后,发现优采云在我需要的范围内没有缺点。当然,也不是真的没有问题,只是大部分功能都有了。它还提供了用于功能扩展的开发接口。商业软件不一样!

优采云软件的帮助文档中有相关教程下载,操作也很简单。

四、在线精神

也是一个知名的网络信息采集工具,我没用过,你可以去官网看看。

最后是前面提到的我们实验室的采集工具,有需要的可以向我索取。该工具还集成了其他文本分析功能。 查看全部

采集工具(基于新浪新闻的全网搜索【iLab开发】思路:与第一种方法)

这两天一直在帮李老师做采集“GEM”主题相关的网络资料,顺便研究了几个不同的网络资料工具采集,包括两个iLab Lab开发的采集工具和两个网上知名的网络资料采集工具。

一、基于谷歌/百度等搜索引擎的全网搜索[iLab开发]

思路:这种方法的基本原理是使用一个通用的搜索引擎,采集它的检索结果。通常取其搜索结果的前 100 页。源码是通过抓取搜索结果条目的url得到的,通过文本提取算法得到原文。因此,一个通用搜索引擎的所有功能,如多重关键词、现场检索等,都可以在这个工具中体现出来。

优点:搜索结果覆盖范围广。

缺点:如果想采集更具体的话题信息,需要指向垂直专业的站点(site:);搜索引擎返回的结果没有固定格式的模板,很难采集全文,只能使用一般的文本提取算法,目前准确率可以达到75%。

二、基于新浪新闻的全网搜索[iLab开发]

思路:与第一种方法类似,这里是新浪的新闻搜索平台。其索引范围包括新浪自己的新闻和其他网站新闻,全文和标题字段均可搜索。抓取方法同上。

优点:由于数据源为新闻报道,数据结构比较规范,便于提取原文。

缺点:覆盖面不足,针对新闻数据。

经测试,新浪搜索平台在标题字段中检索,主题相关性更强,新浪自有新闻数据保存较好。因此,我们的工具选择了采集“新浪新闻+标题”的检索方式得到的结果。

三、优采云

很早以前就听说过这个采集工具,但是前两天实际使用的时候,发现它的功能真的很强大。几乎任何浏览器都可以访问信息采集,还集成了分词等功能。在做多级链接采集和分页采集的时候也很方便。网上有免费版可供下载,商业版功能和售后服务更完善。

思路:优采云采集的基本思路是url采集+内容模板设置。它还提供全面的数据保存和发布功能。

优点:可以是 采集 特定的网站 和板;完全符合。

缺点:了解了它的所有特性后,发现优采云在我需要的范围内没有缺点。当然,也不是真的没有问题,只是大部分功能都有了。它还提供了用于功能扩展的开发接口。商业软件不一样!

优采云软件的帮助文档中有相关教程下载,操作也很简单。

四、在线精神

也是一个知名的网络信息采集工具,我没用过,你可以去官网看看。

最后是前面提到的我们实验室的采集工具,有需要的可以向我索取。该工具还集成了其他文本分析功能。

采集工具(我推荐一个app:疯狂的,我想你都用过)

采集交流 • 优采云 发表了文章 • 0 个评论 • 115 次浏览 • 2022-03-29 20:04

采集工具我推荐一个app:疯狂的,我平时用来采集一些我喜欢的店铺的商品然后会自动同步到我微信里面,非常方便,

天猫精灵我想你都用过。只要你说你想开始,就可以训练。回答就是会。不过我开始的时候不晓得如何操作。

我上看到好物也会去上面去看。

我看大家的都是各种软件什么的,有人回答题主app的我也是醉了,没经历过吧。我是用了下助手的网站,然后点个“我想提取”,搜索你要的东西,然后点开它选择你想要的文件夹,最后就提取成功了。重要的是之前是要提取所有的商品文件,并且确保你想要的包括的商品都在,建议多操作几次。我是上完图上助手重新看一下,这里好像就不行,莫非要手动点开放在这里才行?!。

拿着自己的截图,去,

小亲亲采集器!超级强大

手机app里面都有。

我看大家都说用app软件,很是不以为然,我也推荐下载专门针对用户设计的助手,说好听点叫了解用户,说难听点就是操作不熟练,操作不明白,操作有困难,小编觉得是自己的问题,总是有运营,总是要走流量,总是要赚钱的,看那么多的技巧就知道了,

网上搜优惠券分享,正在用这个, 查看全部

采集工具(我推荐一个app:疯狂的,我想你都用过)

采集工具我推荐一个app:疯狂的,我平时用来采集一些我喜欢的店铺的商品然后会自动同步到我微信里面,非常方便,

天猫精灵我想你都用过。只要你说你想开始,就可以训练。回答就是会。不过我开始的时候不晓得如何操作。

我上看到好物也会去上面去看。

我看大家的都是各种软件什么的,有人回答题主app的我也是醉了,没经历过吧。我是用了下助手的网站,然后点个“我想提取”,搜索你要的东西,然后点开它选择你想要的文件夹,最后就提取成功了。重要的是之前是要提取所有的商品文件,并且确保你想要的包括的商品都在,建议多操作几次。我是上完图上助手重新看一下,这里好像就不行,莫非要手动点开放在这里才行?!。

拿着自己的截图,去,

小亲亲采集器!超级强大

手机app里面都有。

我看大家都说用app软件,很是不以为然,我也推荐下载专门针对用户设计的助手,说好听点叫了解用户,说难听点就是操作不熟练,操作不明白,操作有困难,小编觉得是自己的问题,总是有运营,总是要走流量,总是要赚钱的,看那么多的技巧就知道了,

网上搜优惠券分享,正在用这个,

采集工具(gmail不是采集工具,是恶意代码的吗?(一))

采集交流 • 优采云 发表了文章 • 0 个评论 • 101 次浏览 • 2022-03-28 21:04

采集工具本身没有攻击,就是恶意代码就是恶意的;收集到的一些协议没有沙箱不能用于攻击。具体的不展开。

论点:请注意,gmail不是采集工具。虽然我不懂技术,但是感觉这问题太笼统了,还是想不出一个好的答案,只能通过问答形式给个提纲吧。一般来说,如果采集任务是个单纯产出数据的完整流程,其实都是采集工具作恶啊。比如把一个网站的url完整抓取下来,那你得知道该怎么格式转化啊,用xml还是json啊,这些从本质上来说就是采集工具作恶,一般的采集工具都要求通过ssl+aes来做传输层和数据报文传输加密啊。

所以你看我们根本不认为它是恶意代码。就以电脑浏览器来说,我一直认为他是像上图那样是在解析你的http协议的,它不窃取你的任何私密信息,只是字面意义上的入侵而已。然后在拿到你的字节流之后,就对浏览器造成攻击了。目前各大浏览器都推出了专门的从源头上对它发起攻击的工具,我随便举个例子,ie,ie它就推出ip欺骗工具和钓鱼工具两个工具,你懂得,它这两个工具是为了阻止web安全协议的传输,是必须开启。

所以说,它的第二类攻击点就在于浏览器协议破解。我没查过网络协议的学术论文,但是这方面的可查的文章肯定远不止此。第三个采集工具我也认为是恶意代码,因为它造成的困扰远大于你提到的其他工具,比如在网站登录信息泄露的情况下使用(第二类攻击),或者在恶意代码篡改后的源码中包含它们的代码(第三类攻击)。--再补充一下,需要说明的是采集工具不是模拟,就拿我自己采集信息的例子来说,我是通过,在采集数据的过程中还使用了cookie来调用“宝贝”的guid值来判断对方的电话号码是否和上次购买商品类似,这样可以作为判断的依据。

在这里提一下:我一直说的网站采集算是代理登录的类型,不是真的和电脑同步采集。例如我这里抓取的以及cnzz(具体的问题可以去博客或知乎搜)都是不记名的,也不像我说的第三类工具这样,有真实号码。 查看全部

采集工具(gmail不是采集工具,是恶意代码的吗?(一))

采集工具本身没有攻击,就是恶意代码就是恶意的;收集到的一些协议没有沙箱不能用于攻击。具体的不展开。

论点:请注意,gmail不是采集工具。虽然我不懂技术,但是感觉这问题太笼统了,还是想不出一个好的答案,只能通过问答形式给个提纲吧。一般来说,如果采集任务是个单纯产出数据的完整流程,其实都是采集工具作恶啊。比如把一个网站的url完整抓取下来,那你得知道该怎么格式转化啊,用xml还是json啊,这些从本质上来说就是采集工具作恶,一般的采集工具都要求通过ssl+aes来做传输层和数据报文传输加密啊。

所以你看我们根本不认为它是恶意代码。就以电脑浏览器来说,我一直认为他是像上图那样是在解析你的http协议的,它不窃取你的任何私密信息,只是字面意义上的入侵而已。然后在拿到你的字节流之后,就对浏览器造成攻击了。目前各大浏览器都推出了专门的从源头上对它发起攻击的工具,我随便举个例子,ie,ie它就推出ip欺骗工具和钓鱼工具两个工具,你懂得,它这两个工具是为了阻止web安全协议的传输,是必须开启。

所以说,它的第二类攻击点就在于浏览器协议破解。我没查过网络协议的学术论文,但是这方面的可查的文章肯定远不止此。第三个采集工具我也认为是恶意代码,因为它造成的困扰远大于你提到的其他工具,比如在网站登录信息泄露的情况下使用(第二类攻击),或者在恶意代码篡改后的源码中包含它们的代码(第三类攻击)。--再补充一下,需要说明的是采集工具不是模拟,就拿我自己采集信息的例子来说,我是通过,在采集数据的过程中还使用了cookie来调用“宝贝”的guid值来判断对方的电话号码是否和上次购买商品类似,这样可以作为判断的依据。

在这里提一下:我一直说的网站采集算是代理登录的类型,不是真的和电脑同步采集。例如我这里抓取的以及cnzz(具体的问题可以去博客或知乎搜)都是不记名的,也不像我说的第三类工具这样,有真实号码。

采集工具(如何使用简单好用的Zblog采集插件工具快速采集排名获取流量)

采集交流 • 优采云 发表了文章 • 0 个评论 • 146 次浏览 • 2022-03-24 23:03

如何使用Zblog采集插件工具快速采集流量排名。最近有很多朋友向我抱怨说我用Zblog采集插件管理不了十个网站。他们每天检查采集 规则,仅仅编写采集 规则就需要很多时间。如果你精通 HTML+css 编写规则会快很多,如果你不熟悉代码。需要更多时间。

案例图

如何使用简单易用的Zblog采集工具快速采集排名并批量获取流量

如何批量管理 Zblog 网站:

一、有批次管理检查工具

Zblog批量发布检测工具

1、监控数据:软件直接监控发布数量,待发布数量,伪原创是否成功,发布状态(是否发布成功),发布网站@ >、发布程序、发布时间等。

详细解答:无论是易友、ZBLOG、织梦、WP、PB、Apple、Sowai等各大cms,都可以同时支持批量管理和发布工具。不同栏目设置不同关键词文章定期发布+每日总发布+数据监控=完美解决低效问题。

二、 Zblog 批处理采集工具

Zblog 批量采集工具

1、 Bulk采集:如果每个 网站 都花费大量时间编写 采集Applecms采集插件的规则,那么就不用再花时间管理 网站 和分析 网站 数据了!批量采集 选择 Zblogs 很重要。它必须易于操作。批处理 采集 只能通过简单的操作来实现。

详细解答:只需导入关键词即可采集相关关键词文章,同时创建几十个或上百个喜欢的任务(一个任务可支持上传1000个关键词@ >文章 @关键词) 什么是苹果的cms采集 插件,支持大平台合集。 (搜狗资讯-微信公众号-搜狗知乎-头条资讯-百度资讯-百度知道-新浪新闻-360资讯-凤凰资讯等,可同时设置多个采集来源采集)

实现自动批量挂机采集,无缝对接各大cms发布者,实现自动挂机采集和发布。

如何实现快速的批量收录和排名:

搜索引擎推送工具

网站刚成立时,搜索引擎会调查网站一段时间,而这段时间对于网站来说是最重要的时期。为了让搜索引擎能够收录网站文章,我们必须积极引导搜索引擎蜘蛛抓取网站文章的内容。

如何快速获取网站流量:网站内容→网站收录→流量排名 查看全部

采集工具(如何使用简单好用的Zblog采集插件工具快速采集排名获取流量)

如何使用Zblog采集插件工具快速采集流量排名。最近有很多朋友向我抱怨说我用Zblog采集插件管理不了十个网站。他们每天检查采集 规则,仅仅编写采集 规则就需要很多时间。如果你精通 HTML+css 编写规则会快很多,如果你不熟悉代码。需要更多时间。

案例图

如何使用简单易用的Zblog采集工具快速采集排名并批量获取流量

如何批量管理 Zblog 网站:

一、有批次管理检查工具

Zblog批量发布检测工具

1、监控数据:软件直接监控发布数量,待发布数量,伪原创是否成功,发布状态(是否发布成功),发布网站@ >、发布程序、发布时间等。

详细解答:无论是易友、ZBLOG、织梦、WP、PB、Apple、Sowai等各大cms,都可以同时支持批量管理和发布工具。不同栏目设置不同关键词文章定期发布+每日总发布+数据监控=完美解决低效问题。

二、 Zblog 批处理采集工具

Zblog 批量采集工具

1、 Bulk采集:如果每个 网站 都花费大量时间编写 采集Applecms采集插件的规则,那么就不用再花时间管理 网站 和分析 网站 数据了!批量采集 选择 Zblogs 很重要。它必须易于操作。批处理 采集 只能通过简单的操作来实现。

详细解答:只需导入关键词即可采集相关关键词文章,同时创建几十个或上百个喜欢的任务(一个任务可支持上传1000个关键词@ >文章 @关键词) 什么是苹果的cms采集 插件,支持大平台合集。 (搜狗资讯-微信公众号-搜狗知乎-头条资讯-百度资讯-百度知道-新浪新闻-360资讯-凤凰资讯等,可同时设置多个采集来源采集)

实现自动批量挂机采集,无缝对接各大cms发布者,实现自动挂机采集和发布。

如何实现快速的批量收录和排名:

搜索引擎推送工具

网站刚成立时,搜索引擎会调查网站一段时间,而这段时间对于网站来说是最重要的时期。为了让搜索引擎能够收录网站文章,我们必须积极引导搜索引擎蜘蛛抓取网站文章的内容。

如何快速获取网站流量:网站内容→网站收录→流量排名

采集工具( 百分百企业名录搜索软件会定期整理最新的企业信息采集软件)

采集交流 • 优采云 发表了文章 • 0 个评论 • 136 次浏览 • 2022-03-21 17:11

百分百企业名录搜索软件会定期整理最新的企业信息采集软件)

百分百企业名录搜索软件是一款准确有效的企业信息采集软件,用户可以根据关键词、地区、行业或自定义搜索条件,准确采集到企业的联系人,手机号、邮箱等工具,快捷高效。采集完成后,就可以自行导出数据了。100%企业名录搜索软件会定期整理最新的企业名录数据,保证用户采集的数据是最新的、可用的。

100%企业名录搜索软件功能

1、按地区生成手机号码

手机号码段根据用户设置的地区生成,可根据指定的号码段和自定义格式生成手机号码,是地域定向营销和群发短信的最佳选择。

2、在线采集通过B2B网站

软件可通过B2B网站online采集访问,如慧聪网、马可波罗、亿虎百影、中国供应商等。B2B网站采集最新企业信息,数据准确,采集速度快,对于想要获取最新企业信息的客户来说是不错的选择

3、百度爬虫采集手机号,目标准确

软件支持网络爬虫搜索手机号功能,根据你的关键词智能搜索百度用户的手机号,目标精准清晰,搜索结果(即手机号)可本地保存,网络营销必备助手

4、覆盖全国各行各业

经我司官方人员精心整理分类,再经过程序的二次精准处理,我司数据库已覆盖全国所有行业,每个行业对应的数据都已定位准确。它是您的发展寻找新客户和潜在客户的最佳工具

5、数据及时更新,保证营销效果

100%的团队,专业的员工,定期整理最新的企业名录数据,我们力求及时更新最新的企业数据,同时优化旧的企业数据,确保您采集通过我们的软件。企业数据是第一手的和最新的。为了您取得更好的营销和销售效果,我们一直在努力

6、采集速度快,稳定性好

软件采用我们团队两年开发的软件内核,在不添加群组的情况下提取群组成员,并利用现有成熟技术力求为您达到最佳的采集速度,而软件的稳定性不完全受影响!不仅可以节省您的时间和效率,还可以让您的营销更省心

7、快速便捷的数据导出,多种格式

凡是购买了我们的软件并成为正式版用户的人,都可以享受软件的导出功能。导出格式,我们支持execel、txt等基本格式,同时我们有人性化的自定义导出格式设置,可以随意导出自己需要的格式

8、软件采用网络账号,不限机器

100%客户整合采集软件采用网络账号形式。一个软件账号可以登录不同的电脑。用户可以在家中或公司使用。它以机器码的形式摆脱了传统软件的弊端。实现以用户为中心、以服务为基础的群发理念

9、软件不断升级完善,售后服务可靠

在升级和维护方面,100%软件团队一直坚持技术创新和脚踏实地的维护,确保软件功能和性能的稳定性。在售后服务方面,百分百软件团队拥有一支训练有素的客服团队,为您提供专业的技术支持

100%企业目录搜索软件使用

⑴首先打开100%软件,可以登录软件账号或者免费试用软件!

(2) 设置要搜索的企业的条件,包括要搜索的关键词和企业所属的行业。您可以一次设置多个 关键词。

(3) 开始搜索企业目录,搜索到的企业目录会显示在显示框中。

⑷搜索成功后,选择目标公司目录,点击导出,将公司目录导出,可以excel和txt格式导出(试用版不支持导出)。

⑹ 试用满意后联系客服购买正式版软件,享受免费升级服务、问答、售后服务。

100% 企业名录搜索软件常见问题解答

(一)免费试用软件有一定的功能限制,限制搜索数据的导出!如果想无限制使用,请购买正版。

(二) Q:软件数据会定期更新吗?多久更新一次?

A:软件采用独创方式,定期更新公司目录和数据库,保证大家的使用效果和用户权限!软件实时更新数据,只要我们官方抓取最新的公司目录,就会第一时间更新并入库!

(三)如果您在使用过程中有任何问题或想对软件改进提出建议,请联系我们的客服进行指导,我们将尽快为您解决问题! 查看全部

采集工具(

百分百企业名录搜索软件会定期整理最新的企业信息采集软件)

百分百企业名录搜索软件是一款准确有效的企业信息采集软件,用户可以根据关键词、地区、行业或自定义搜索条件,准确采集到企业的联系人,手机号、邮箱等工具,快捷高效。采集完成后,就可以自行导出数据了。100%企业名录搜索软件会定期整理最新的企业名录数据,保证用户采集的数据是最新的、可用的。

100%企业名录搜索软件功能

1、按地区生成手机号码

手机号码段根据用户设置的地区生成,可根据指定的号码段和自定义格式生成手机号码,是地域定向营销和群发短信的最佳选择。

2、在线采集通过B2B网站