网页qq抓取什么原理

网页qq抓取什么原理(网络爬虫是怎么工作的?工作原理是怎样的呢的 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 77 次浏览 • 2021-11-08 19:06

)

前几天有朋友问我什么是网络爬虫?像那种毛毛虫吗?我想当初我没进入这个行业的时候,我以为我理解了这个概念之后会变得更清楚。那么今天有必要跟大家分享一下网络爬虫是如何工作的,它是如何工作的?

百度百科解释网络爬虫

网络蜘蛛又称网络爬虫、蚂蚁、自动索引器,或(FOAF软件概念中)WEB scatter,是一种“自动网页浏览”程序,或者一种网络机器人。其他不太常用的名称是蚂蚁、自动索引、模拟器或蠕虫。它们被广泛用于互联网搜索引擎或其他类似的网站,以获取或更新这些网站的内容和检索方法。它们可以自动采集 可以访问的页面的所有内容,供搜索引擎进一步处理(检查和整理下载的页面),以便用户可以更快地检索到所需的信息。

维基百科网络蜘蛛

网络爬虫(也称为网络蜘蛛、网络机器人,在 FOAF 社区中,更常见的是网络追逐)是按照某些规则自动抓取万维网上信息的程序或脚本。网络爬虫框架主要由控制器、解析器和索引库三部分组成。爬虫的工作原理主要是解析器。解析器的主要工作是下载网页并处理页面,主要是添加一些JS脚本标签。、CSS代码内容、空格字符、HTML标签等内容的处理,爬虫的基本工作由解析器完成,所以解析器的详细流程为:

那么爬虫是如何工作的呢?

简单的说,爬虫就是爬取目标网站内容的工具。一般情况下,它会根据定义的行为自动爬行。更智能的爬虫会自动分析目标。目标网站的结构类似于搜索引擎的结构。这里只讨论基本的爬虫原理。

网络爬虫的基本工作流程如下:

1.首先选择一些精心挑选的种子网址;

2.将这些URL放入URL队列进行抓取;

3. 从待爬取的URL队列中取出待爬取的URL,解析DNS,获取主机IP,下载该URL对应的网页,并保存到下载的网页库中。另外,将这些 URL 放入爬取的 URL 队列中。

4.对爬取的URL队列中的URL进行分析,分析其中的其他URL,将这些URL放入URL队列进行爬取,从而进入下一个循环。

总结一下基本例程是:

基本例程可以划分如下:

入口访问 -> 下载内容 -> 分析结构 -> 提取内容

最终以快照的形式呈现在搜索引擎上。如图所示

以下是常见的搜索引擎爬虫类别:

Google爬虫

算法优秀,反应速度迅速,对内容质量把握优秀,中等强度爬虫程序, 对服务器负担不大,推广效果好。

对应user-agent:爬虫名称

Googlebot:google网页爬虫

Googlebot-news:google新闻爬虫

Googlebot-image:google图片爬虫

Googlebot-video:google视频爬虫

Googlebot-mobile:google移动爬虫

Mediapartners-google或Mediapartners(googlebot):google广告爬虫

Adsbot-google:google着陆页质量检测爬虫

百度爬虫

算法良好,反应速度迟钝,对内容质量把握一般,高强度爬虫程序,由于算法优化不良问题,

对服务器负担较大,本身小问题也挺多,隐私保护恶劣,在百度面前无隐私可言,推广效果好。

对应user-agent:爬虫名称

Baiduspider:百度网页爬虫兼移动爬虫

Baiduspider-image:百度图片爬虫

Baiduspider-video:百度视频爬虫

Baiduspider-news:百度新闻爬虫

Baiduspider-favo:百度搜藏爬虫

Baiduspider-cpro:百度联盟爬虫

Baiduspider-ads:百度商务爬虫

好搜(即360爬虫)

对应user-agent:爬虫名称

360spider或haosouspider:好搜网页爬虫兼移动爬虫

360spider-image:好搜图片爬虫

360spider-video:好搜视频爬虫

搜狗爬虫

算法恶劣,反应速度极其迟钝,不能良好的把握内容质量,高强度爬虫程序,由于算法奇差,

会对页面进行大量反复而又无实际意义的扫描,对服务器负担很大,抓取压力大,综合性价比非常低。

对应user-agent:爬虫名称

Sogou spider:搜狗综合爬虫

新浪爱问爬虫

对应user-agent:爬虫名称

Iaskspider:新浪爱问爬虫

有道爬虫

对应user-agent:爬虫名称

YodaoBot:网易有道爬虫

Alexa爬虫

对应user-agent:爬虫名称

ia_archiver:Alexa爬虫

雅虎爬虫

对应user-agent:爬虫名称

Yahoo! Slurp:雅虎爬虫

必应爬虫

对应user-agent:爬虫名称

Bingbot:必应爬虫

爬虫基本都属这些类。 查看全部

网页qq抓取什么原理(网络爬虫是怎么工作的?工作原理是怎样的呢的

)

前几天有朋友问我什么是网络爬虫?像那种毛毛虫吗?我想当初我没进入这个行业的时候,我以为我理解了这个概念之后会变得更清楚。那么今天有必要跟大家分享一下网络爬虫是如何工作的,它是如何工作的?

https://www.xiaofeiseo.com/wp- ... 0.jpg 281w" />

https://www.xiaofeiseo.com/wp- ... 0.jpg 281w" />百度百科解释网络爬虫

网络蜘蛛又称网络爬虫、蚂蚁、自动索引器,或(FOAF软件概念中)WEB scatter,是一种“自动网页浏览”程序,或者一种网络机器人。其他不太常用的名称是蚂蚁、自动索引、模拟器或蠕虫。它们被广泛用于互联网搜索引擎或其他类似的网站,以获取或更新这些网站的内容和检索方法。它们可以自动采集 可以访问的页面的所有内容,供搜索引擎进一步处理(检查和整理下载的页面),以便用户可以更快地检索到所需的信息。

维基百科网络蜘蛛

网络爬虫(也称为网络蜘蛛、网络机器人,在 FOAF 社区中,更常见的是网络追逐)是按照某些规则自动抓取万维网上信息的程序或脚本。网络爬虫框架主要由控制器、解析器和索引库三部分组成。爬虫的工作原理主要是解析器。解析器的主要工作是下载网页并处理页面,主要是添加一些JS脚本标签。、CSS代码内容、空格字符、HTML标签等内容的处理,爬虫的基本工作由解析器完成,所以解析器的详细流程为:

https://www.xiaofeiseo.com/wp- ... 6.png 600w, https://www.xiaofeiseo.com/wp- ... 8.png 300w, https://www.xiaofeiseo.com/wp- ... 7.png 768w" />

https://www.xiaofeiseo.com/wp- ... 6.png 600w, https://www.xiaofeiseo.com/wp- ... 8.png 300w, https://www.xiaofeiseo.com/wp- ... 7.png 768w" />那么爬虫是如何工作的呢?

简单的说,爬虫就是爬取目标网站内容的工具。一般情况下,它会根据定义的行为自动爬行。更智能的爬虫会自动分析目标。目标网站的结构类似于搜索引擎的结构。这里只讨论基本的爬虫原理。

网络爬虫的基本工作流程如下:

1.首先选择一些精心挑选的种子网址;

2.将这些URL放入URL队列进行抓取;

3. 从待爬取的URL队列中取出待爬取的URL,解析DNS,获取主机IP,下载该URL对应的网页,并保存到下载的网页库中。另外,将这些 URL 放入爬取的 URL 队列中。

4.对爬取的URL队列中的URL进行分析,分析其中的其他URL,将这些URL放入URL队列进行爬取,从而进入下一个循环。

总结一下基本例程是:

基本例程可以划分如下:

入口访问 -> 下载内容 -> 分析结构 -> 提取内容

最终以快照的形式呈现在搜索引擎上。如图所示

https://www.xiaofeiseo.com/wp- ... 1.png 300w" />

https://www.xiaofeiseo.com/wp- ... 1.png 300w" />以下是常见的搜索引擎爬虫类别:

Google爬虫

算法优秀,反应速度迅速,对内容质量把握优秀,中等强度爬虫程序, 对服务器负担不大,推广效果好。

对应user-agent:爬虫名称

Googlebot:google网页爬虫

Googlebot-news:google新闻爬虫

Googlebot-image:google图片爬虫

Googlebot-video:google视频爬虫

Googlebot-mobile:google移动爬虫

Mediapartners-google或Mediapartners(googlebot):google广告爬虫

Adsbot-google:google着陆页质量检测爬虫

百度爬虫

算法良好,反应速度迟钝,对内容质量把握一般,高强度爬虫程序,由于算法优化不良问题,

对服务器负担较大,本身小问题也挺多,隐私保护恶劣,在百度面前无隐私可言,推广效果好。

对应user-agent:爬虫名称

Baiduspider:百度网页爬虫兼移动爬虫

Baiduspider-image:百度图片爬虫

Baiduspider-video:百度视频爬虫

Baiduspider-news:百度新闻爬虫

Baiduspider-favo:百度搜藏爬虫

Baiduspider-cpro:百度联盟爬虫

Baiduspider-ads:百度商务爬虫

好搜(即360爬虫)

对应user-agent:爬虫名称

360spider或haosouspider:好搜网页爬虫兼移动爬虫

360spider-image:好搜图片爬虫

360spider-video:好搜视频爬虫

搜狗爬虫

算法恶劣,反应速度极其迟钝,不能良好的把握内容质量,高强度爬虫程序,由于算法奇差,

会对页面进行大量反复而又无实际意义的扫描,对服务器负担很大,抓取压力大,综合性价比非常低。

对应user-agent:爬虫名称

Sogou spider:搜狗综合爬虫

新浪爱问爬虫

对应user-agent:爬虫名称

Iaskspider:新浪爱问爬虫

有道爬虫

对应user-agent:爬虫名称

YodaoBot:网易有道爬虫

Alexa爬虫

对应user-agent:爬虫名称

ia_archiver:Alexa爬虫

雅虎爬虫

对应user-agent:爬虫名称

Yahoo! Slurp:雅虎爬虫

必应爬虫

对应user-agent:爬虫名称

Bingbot:必应爬虫

爬虫基本都属这些类。

网页qq抓取什么原理(百度搜索引擎工作原理分析(2)IIS日志日志)

网站优化 • 优采云 发表了文章 • 0 个评论 • 76 次浏览 • 2021-11-06 04:07

百度搜索引擎工作原理解析-百度搜索引擎工作原理

(2)服务器 IIS 日志

如果您的服务器启用了 IIS 日志记录,您还可以通过 IIS 日志文件查看蜘蛛跟踪。通过IIS日志,我们可以发现百度蜘蛛正在抓取我们的页面。

4. 影响蜘蛛爬行的因素

好的,我们知道 网站 想要排名。第一步是能够被蜘蛛爬行。这些因素可能会阻止蜘蛛正常抓取我们的网页。我们应该注意以下几点:

(1)网址不能太长:百度建议网址长度不要超过256字节(英文字母(不区分大小写)占一字节空间,一个汉字占两字节空间) .

(2)不要在网址中收录中文:百度对中文网址的抓取效果比较差,所以不要在网址中收录中文。

(3)服务器问题:如果你的服务器质量不好,打不开,也会影响蜘蛛的爬取效果。

(4)Robots.txt屏蔽:部分SEO人员疏忽,你想被百度抓取的路径或页面在Robots.txt文件中被屏蔽。这也会影响百度对我们网站的抓取取效果。

(5)避免蜘蛛难以解析的字符,如/abc/123456 ;;;;;;;%B9&CE%EDDS$GHWF%.html 这个网址蜘蛛无法理解,放弃抓取。

(6)注意动态参数不要太复杂,目前百度对动态网址的处理还是不错的,但是蜘蛛可能会因为不重要而放弃太多的参数和复杂的网址。这一点尤其重要。所以当心。

百度搜索引擎-过滤模块的工作原理

由于互联网上充斥着垃圾邮件页面和无内容页面,搜索引擎或搜索用户不需要这些页面。因此,为了防止这些垃圾页面占用其宝贵的存储资源,搜索引擎会对蜘蛛抓取的内容进行过滤。执行这个操作的模块就是我们所说的过滤模块。这些因素会影响过滤器模块,有以下两点:

(1)标识

由于搜索引擎蜘蛛目前最擅长分析文本和链接,因此很难识别图像和视频。因此,如果页面以图片和视频为主,搜索引擎很难识别页面的内容。对于此类页面,搜索引擎可能会被过滤为垃圾邮件网站。所以我们在编辑网站的内容的时候,应该添加一些文字说明,这样过滤模块就不容易过滤了。

(2)内容质量

基于可识别的内容,搜索引擎还将捕获的网页内容与已存储在数据库中的内容进行比较。如果搜索引擎发现页面内容的质量大部分与数据库中的内容重复,或者质量较差,则该页面将被过滤掉。

百度搜索引擎的工作原理——包括模块

经过过滤模块“验证”过的网页,会被标准化为分词和数据格式,然后存储在索引数据库程序模块中,我们称之为收录模块。如果你的网站有幸通过了收录的模块,那么你就有机会获得排名。

1.如何查看一个网页是否被收录

最简单的方法是将网页的网址复制到百度搜索框中进行搜索。如果可以显示页面的搜索结果,则表示收录该网址。

百度搜索引擎工作原理解析-百度搜索引擎原理

2.如何查看网站的数量

有两种方式:

(1)网站 命令

通过“站点:域名”命令,我们可以看到搜索引擎抓取了某个域名下的页面量:

百度搜索引擎工作原理解析-百度网盘搜索引擎原理

(2)百度“索引量”查询工具

通过百度提供的“指数金额”查询工具,您还可以查询我们网站的数量。

如果我有少量收录怎么办?

这分为两种情况:

(1)新站

一般来说,新站刚刚上线,至少需要1-2个月的时间才能开始采集。在早期阶段,它通常只是一个主页。这种情况没有其他办法可以解决,因为百度特别延长了新网站的审核时间,防止垃圾网站泛滥。因此,如果您正在运营一个新站,您不必担心收录在内。只要你诚实地提供优质内容,百度将在2个月内开始收录你的内页。

(2)老站

即使音量开始减少,一些旧电台的条目也会减少。这通常是由于 网站 内部页面上的内容质量不佳造成的。

这时候网站管理员应该快速调整整个网站的内容质量,提供优质的内容,保证网站的排名不会发生变化。

百度搜索引擎排序模块的工作原理

对于索引数据库中存储的页面,通过一系列算法获取每个页面的权重并对其进行排序的程序称为排序模块。

如果您的页面通过排序模块的计算排在关键字的顶部,那么当搜索用户搜索该关键字时,您的页面就可以展示在用户面前。想要获得适合自己的排名网站,需要做到以下2点:

1.提升基础优化

想要获得好的排名,那么你的网页首先要进行优化,包括网站定位、网站结构、网站布局、网站内容等。这些基础优化的内容后面会详细讲解。只有对这些基础部分进行改进和优化,才能通过。

2. 良好的综合数据

在基础优化的基础上,如果你的百度统计后台数据好,用户忠诚度和站外推广效果显着,就会给投放线加分。只要你的奖励积分超过所有对手,你的网站就可以排在所有对手的前面。原创A5首发,由防爆控制盒整理发布原创,转发时请注明版权,无版权禁止转发。感谢您返回搜狐查看更多 查看全部

网页qq抓取什么原理(百度搜索引擎工作原理分析(2)IIS日志日志)

百度搜索引擎工作原理解析-百度搜索引擎工作原理

(2)服务器 IIS 日志

如果您的服务器启用了 IIS 日志记录,您还可以通过 IIS 日志文件查看蜘蛛跟踪。通过IIS日志,我们可以发现百度蜘蛛正在抓取我们的页面。

4. 影响蜘蛛爬行的因素

好的,我们知道 网站 想要排名。第一步是能够被蜘蛛爬行。这些因素可能会阻止蜘蛛正常抓取我们的网页。我们应该注意以下几点:

(1)网址不能太长:百度建议网址长度不要超过256字节(英文字母(不区分大小写)占一字节空间,一个汉字占两字节空间) .

(2)不要在网址中收录中文:百度对中文网址的抓取效果比较差,所以不要在网址中收录中文。

(3)服务器问题:如果你的服务器质量不好,打不开,也会影响蜘蛛的爬取效果。

(4)Robots.txt屏蔽:部分SEO人员疏忽,你想被百度抓取的路径或页面在Robots.txt文件中被屏蔽。这也会影响百度对我们网站的抓取取效果。

(5)避免蜘蛛难以解析的字符,如/abc/123456 ;;;;;;;%B9&CE%EDDS$GHWF%.html 这个网址蜘蛛无法理解,放弃抓取。

(6)注意动态参数不要太复杂,目前百度对动态网址的处理还是不错的,但是蜘蛛可能会因为不重要而放弃太多的参数和复杂的网址。这一点尤其重要。所以当心。

百度搜索引擎-过滤模块的工作原理

由于互联网上充斥着垃圾邮件页面和无内容页面,搜索引擎或搜索用户不需要这些页面。因此,为了防止这些垃圾页面占用其宝贵的存储资源,搜索引擎会对蜘蛛抓取的内容进行过滤。执行这个操作的模块就是我们所说的过滤模块。这些因素会影响过滤器模块,有以下两点:

(1)标识

由于搜索引擎蜘蛛目前最擅长分析文本和链接,因此很难识别图像和视频。因此,如果页面以图片和视频为主,搜索引擎很难识别页面的内容。对于此类页面,搜索引擎可能会被过滤为垃圾邮件网站。所以我们在编辑网站的内容的时候,应该添加一些文字说明,这样过滤模块就不容易过滤了。

(2)内容质量

基于可识别的内容,搜索引擎还将捕获的网页内容与已存储在数据库中的内容进行比较。如果搜索引擎发现页面内容的质量大部分与数据库中的内容重复,或者质量较差,则该页面将被过滤掉。

百度搜索引擎的工作原理——包括模块

经过过滤模块“验证”过的网页,会被标准化为分词和数据格式,然后存储在索引数据库程序模块中,我们称之为收录模块。如果你的网站有幸通过了收录的模块,那么你就有机会获得排名。

1.如何查看一个网页是否被收录

最简单的方法是将网页的网址复制到百度搜索框中进行搜索。如果可以显示页面的搜索结果,则表示收录该网址。

百度搜索引擎工作原理解析-百度搜索引擎原理

2.如何查看网站的数量

有两种方式:

(1)网站 命令

通过“站点:域名”命令,我们可以看到搜索引擎抓取了某个域名下的页面量:

百度搜索引擎工作原理解析-百度网盘搜索引擎原理

(2)百度“索引量”查询工具

通过百度提供的“指数金额”查询工具,您还可以查询我们网站的数量。

如果我有少量收录怎么办?

这分为两种情况:

(1)新站

一般来说,新站刚刚上线,至少需要1-2个月的时间才能开始采集。在早期阶段,它通常只是一个主页。这种情况没有其他办法可以解决,因为百度特别延长了新网站的审核时间,防止垃圾网站泛滥。因此,如果您正在运营一个新站,您不必担心收录在内。只要你诚实地提供优质内容,百度将在2个月内开始收录你的内页。

(2)老站

即使音量开始减少,一些旧电台的条目也会减少。这通常是由于 网站 内部页面上的内容质量不佳造成的。

这时候网站管理员应该快速调整整个网站的内容质量,提供优质的内容,保证网站的排名不会发生变化。

百度搜索引擎排序模块的工作原理

对于索引数据库中存储的页面,通过一系列算法获取每个页面的权重并对其进行排序的程序称为排序模块。

如果您的页面通过排序模块的计算排在关键字的顶部,那么当搜索用户搜索该关键字时,您的页面就可以展示在用户面前。想要获得适合自己的排名网站,需要做到以下2点:

1.提升基础优化

想要获得好的排名,那么你的网页首先要进行优化,包括网站定位、网站结构、网站布局、网站内容等。这些基础优化的内容后面会详细讲解。只有对这些基础部分进行改进和优化,才能通过。

2. 良好的综合数据

在基础优化的基础上,如果你的百度统计后台数据好,用户忠诚度和站外推广效果显着,就会给投放线加分。只要你的奖励积分超过所有对手,你的网站就可以排在所有对手的前面。原创A5首发,由防爆控制盒整理发布原创,转发时请注明版权,无版权禁止转发。感谢您返回搜狐查看更多

网页qq抓取什么原理(百度蜘蛛构建一个调度程序,来调度蜘蛛池)

网站优化 • 优采云 发表了文章 • 0 个评论 • 66 次浏览 • 2021-11-04 22:15

这时候就不得不说蜘蛛是什么了,这里以百度蜘蛛为例。百度蜘蛛的构建原理。搜索引擎构建调度器来调度百度蜘蛛的工作,并允许百度蜘蛛与服务器建立连接下载网页。计算过程通过调度计算。百度蜘蛛只负责下载网页。当前的搜索引擎被广泛使用。分布式多服务器多线程的百度蜘蛛达到了多线程的目的。

那么什么是蜘蛛池呢?

蜘蛛池程序的原理是捕获进入变量模板生成网页的蜘蛛,让它不断在这些页面中爬行,并使用我们需要的URL收录作为蜘蛛的出口。这样我们就可以利用我们需要收录的URL进行大量蜘蛛爬取,大大提高了页面收录的可能性。所谓蜘蛛池,是指创建大量泛站点,让搜索引擎收录作为自己的外链资源。当有新的网站或者新的页面时,把新的URL放到这些泛站点资源页面上,就可以立即得到蜘蛛的爬取和权重转移。

蜘蛛池原理

蜘蛛池通过程序判断,捕获搜索引擎蜘蛛并不断抓取网页,只提供提交的链接作为蜘蛛出口。简单的说,蜘蛛池就是用多个域名构建多个网站,然后将这些网站相互链接起来,形成一个死循环,然后发布大量的信息化信息并引入蜘蛛,此时蜘蛛会跟着这个圈子不断地爬行,形成一个蜘蛛池。我们知道一个网站的收录,最基本的因素就是被百度爬了,心战一般百度爬的很少,所以只要把你的网站嵌入表单蜘蛛池每个页面的锚文本(这是php操作的技术),可以直接获取大量蜘蛛,可以快速提升收录的效果。好吧,我想你一定不明白。说白了,蜘蛛池就是由一堆域名站群组成的。每个站点下都会生成海量的页面(抓取一堆文本内容相互组合),页面模板与普通网页没有太大区别。由于每个站点都有大量的页面,整个站群爬取的蜘蛛总数也是巨大的。将蜘蛛引用到一个没有收录的页面,就是在站群的普通网页模板中打开一个单独的DIV,插入一个没有收录的网页链接,服务器没有缓存,蜘蛛每次访问,这个DIV显示的链接都不一样。@收录。好吧,我想你一定不明白。说白了,蜘蛛池就是由一堆域名站群组成的。每个站点下都会生成海量的页面(抓取一堆文本内容相互组合),页面模板与普通网页没有太大区别。由于每个站点都有大量的页面,整个站群爬取的蜘蛛总数也是巨大的。将蜘蛛引用到一个没有收录的页面,就是在站群的普通网页模板中打开一个单独的DIV,插入一个没有收录的网页链接,服务器没有缓存,蜘蛛每次访问,这个DIV显示的链接都不一样。@收录。好吧,我想你一定不明白。说白了,蜘蛛池就是由一堆域名站群组成的。每个站点下都会生成海量的页面(抓取一堆文本内容相互组合),页面模板与普通网页没有太大区别。由于每个站点都有大量的页面,整个站群爬取的蜘蛛总数也是巨大的。将蜘蛛引用到一个没有收录的页面,就是在站群的普通网页模板中打开一个单独的DIV,插入一个没有收录的网页链接,服务器没有缓存,蜘蛛每次访问,这个DIV显示的链接都不一样。蜘蛛池由一堆域名站群组成。每个站点下都会生成海量的页面(抓取一堆文本内容相互组合),页面模板与普通网页没有太大区别。由于每个站点都有大量的页面,整个站群爬取的蜘蛛总数也是巨大的。将蜘蛛引用到一个没有收录的页面,就是在站群的普通网页模板中打开一个单独的DIV,插入一个没有收录的网页链接,服务器没有缓存,蜘蛛每次访问,这个DIV显示的链接都不一样。蜘蛛池由一堆域名站群组成。每个站点下都会生成海量的页面(抓取一堆文本内容相互组合),页面模板与普通网页没有太大区别。由于每个站点都有大量的页面,整个站群爬取的蜘蛛总数也是巨大的。将蜘蛛引用到一个没有收录的页面,就是在站群的普通网页模板中打开一个单独的DIV,插入一个没有收录的网页链接,服务器没有缓存,蜘蛛每次访问,这个DIV显示的链接都不一样。并且页面模板与普通网页没有太大区别。由于每个站点都有大量的页面,整个站群爬取的蜘蛛总数也是巨大的。将蜘蛛引用到一个没有收录的页面,就是在站群的普通网页模板中打开一个单独的DIV,插入一个没有收录的网页链接,服务器没有缓存,蜘蛛每次访问,这个DIV显示的链接都不一样。并且页面模板与普通网页没有太大区别。由于每个站点都有大量的页面,整个站群爬取的蜘蛛总数也是巨大的。将蜘蛛引用到一个没有收录的页面,就是在站群的普通网页模板中打开一个单独的DIV,插入一个没有收录的网页链接,服务器没有缓存,蜘蛛每次访问,这个DIV显示的链接都不一样。

蜘蛛池本质上是希望解决一个问题,核心是吸引蜘蛛的问题。吸引蜘蛛的目的是让蜘蛛在网站中发现这些新页面或收录中没有的页面。但希望被发现并不是现阶段的核心问题。那么多的网站地图,那么多的API接口都可以向搜索引擎提交数据。完全可以尽快通知搜索引擎,网站有内容更新。

既然蜘蛛池可以理解为站群,那么站群的主要特点之一就是它的可管理性,虽然很多人做站群是为了获取流量,转化为广告,形成利润收获,还有一个更高的操作就是蜘蛛池,因为当你有这么庞大的站群时,只要在页面上放链接,搜索引擎蜘蛛就可以快速找到这些链接。从而使搜索引擎的收录 索引。

总结:

但是不管怎样,你的网站结构不好,或者文章的质量不好,不管你计算多少蜘蛛,都不一定是收录,所以发送更多优质内容,坚持原创文章,坚持才能胜利~ 查看全部

网页qq抓取什么原理(百度蜘蛛构建一个调度程序,来调度蜘蛛池)

这时候就不得不说蜘蛛是什么了,这里以百度蜘蛛为例。百度蜘蛛的构建原理。搜索引擎构建调度器来调度百度蜘蛛的工作,并允许百度蜘蛛与服务器建立连接下载网页。计算过程通过调度计算。百度蜘蛛只负责下载网页。当前的搜索引擎被广泛使用。分布式多服务器多线程的百度蜘蛛达到了多线程的目的。

那么什么是蜘蛛池呢?

蜘蛛池程序的原理是捕获进入变量模板生成网页的蜘蛛,让它不断在这些页面中爬行,并使用我们需要的URL收录作为蜘蛛的出口。这样我们就可以利用我们需要收录的URL进行大量蜘蛛爬取,大大提高了页面收录的可能性。所谓蜘蛛池,是指创建大量泛站点,让搜索引擎收录作为自己的外链资源。当有新的网站或者新的页面时,把新的URL放到这些泛站点资源页面上,就可以立即得到蜘蛛的爬取和权重转移。

蜘蛛池原理

蜘蛛池通过程序判断,捕获搜索引擎蜘蛛并不断抓取网页,只提供提交的链接作为蜘蛛出口。简单的说,蜘蛛池就是用多个域名构建多个网站,然后将这些网站相互链接起来,形成一个死循环,然后发布大量的信息化信息并引入蜘蛛,此时蜘蛛会跟着这个圈子不断地爬行,形成一个蜘蛛池。我们知道一个网站的收录,最基本的因素就是被百度爬了,心战一般百度爬的很少,所以只要把你的网站嵌入表单蜘蛛池每个页面的锚文本(这是php操作的技术),可以直接获取大量蜘蛛,可以快速提升收录的效果。好吧,我想你一定不明白。说白了,蜘蛛池就是由一堆域名站群组成的。每个站点下都会生成海量的页面(抓取一堆文本内容相互组合),页面模板与普通网页没有太大区别。由于每个站点都有大量的页面,整个站群爬取的蜘蛛总数也是巨大的。将蜘蛛引用到一个没有收录的页面,就是在站群的普通网页模板中打开一个单独的DIV,插入一个没有收录的网页链接,服务器没有缓存,蜘蛛每次访问,这个DIV显示的链接都不一样。@收录。好吧,我想你一定不明白。说白了,蜘蛛池就是由一堆域名站群组成的。每个站点下都会生成海量的页面(抓取一堆文本内容相互组合),页面模板与普通网页没有太大区别。由于每个站点都有大量的页面,整个站群爬取的蜘蛛总数也是巨大的。将蜘蛛引用到一个没有收录的页面,就是在站群的普通网页模板中打开一个单独的DIV,插入一个没有收录的网页链接,服务器没有缓存,蜘蛛每次访问,这个DIV显示的链接都不一样。@收录。好吧,我想你一定不明白。说白了,蜘蛛池就是由一堆域名站群组成的。每个站点下都会生成海量的页面(抓取一堆文本内容相互组合),页面模板与普通网页没有太大区别。由于每个站点都有大量的页面,整个站群爬取的蜘蛛总数也是巨大的。将蜘蛛引用到一个没有收录的页面,就是在站群的普通网页模板中打开一个单独的DIV,插入一个没有收录的网页链接,服务器没有缓存,蜘蛛每次访问,这个DIV显示的链接都不一样。蜘蛛池由一堆域名站群组成。每个站点下都会生成海量的页面(抓取一堆文本内容相互组合),页面模板与普通网页没有太大区别。由于每个站点都有大量的页面,整个站群爬取的蜘蛛总数也是巨大的。将蜘蛛引用到一个没有收录的页面,就是在站群的普通网页模板中打开一个单独的DIV,插入一个没有收录的网页链接,服务器没有缓存,蜘蛛每次访问,这个DIV显示的链接都不一样。蜘蛛池由一堆域名站群组成。每个站点下都会生成海量的页面(抓取一堆文本内容相互组合),页面模板与普通网页没有太大区别。由于每个站点都有大量的页面,整个站群爬取的蜘蛛总数也是巨大的。将蜘蛛引用到一个没有收录的页面,就是在站群的普通网页模板中打开一个单独的DIV,插入一个没有收录的网页链接,服务器没有缓存,蜘蛛每次访问,这个DIV显示的链接都不一样。并且页面模板与普通网页没有太大区别。由于每个站点都有大量的页面,整个站群爬取的蜘蛛总数也是巨大的。将蜘蛛引用到一个没有收录的页面,就是在站群的普通网页模板中打开一个单独的DIV,插入一个没有收录的网页链接,服务器没有缓存,蜘蛛每次访问,这个DIV显示的链接都不一样。并且页面模板与普通网页没有太大区别。由于每个站点都有大量的页面,整个站群爬取的蜘蛛总数也是巨大的。将蜘蛛引用到一个没有收录的页面,就是在站群的普通网页模板中打开一个单独的DIV,插入一个没有收录的网页链接,服务器没有缓存,蜘蛛每次访问,这个DIV显示的链接都不一样。

蜘蛛池本质上是希望解决一个问题,核心是吸引蜘蛛的问题。吸引蜘蛛的目的是让蜘蛛在网站中发现这些新页面或收录中没有的页面。但希望被发现并不是现阶段的核心问题。那么多的网站地图,那么多的API接口都可以向搜索引擎提交数据。完全可以尽快通知搜索引擎,网站有内容更新。

既然蜘蛛池可以理解为站群,那么站群的主要特点之一就是它的可管理性,虽然很多人做站群是为了获取流量,转化为广告,形成利润收获,还有一个更高的操作就是蜘蛛池,因为当你有这么庞大的站群时,只要在页面上放链接,搜索引擎蜘蛛就可以快速找到这些链接。从而使搜索引擎的收录 索引。

总结:

但是不管怎样,你的网站结构不好,或者文章的质量不好,不管你计算多少蜘蛛,都不一定是收录,所以发送更多优质内容,坚持原创文章,坚持才能胜利~

网页qq抓取什么原理( 本文由金楠于2016-12-213:17发布在SEO网站优化阅读)

网站优化 • 优采云 发表了文章 • 0 个评论 • 61 次浏览 • 2021-11-04 19:03

本文由金楠于2016-12-213:17发布在SEO网站优化阅读)

搜索引擎如何抓取和处理网页

本文由金楠发表于2016-12-2 13:17 SEO网站优化阅读:2554

服务器处理是对蜘蛛爬取的网页的处理。它是提高搜索准确性和用户体验的重要组成部分。和爬虫一样,是搜索引擎后台处理的一部分。

搜索引擎蜘蛛抓取的网页数据不能直接参与排名。由于数据量过大,如果直接被搜索者检索,大量相关网页的排名计算量非常大,不可能在一两秒内给用户提供答案。因此,搜索引擎会对抓取到的网页进行预处理,得到关键词的索引,相当于对网页上的每一个关键词进行预排序,用户在搜索时可以更快的获得搜索结果。.

服务器处理网页的工作通常包括网页结构化、分词、去噪和去重、索引、超链接分析、数据集成等。

(1)网页结构化:从网页中提取有用信息,去除HTML代码和足迹,剩下的文字信息就是服务器需要分析处理的数据。

搜索引擎蜘蛛抓取的网页收录了整个网页的所有信息。导航、类别列表、友情链接,甚至广告都会被抓取到搜索引擎。此类内容不能直接用于预排序处理。. 因此,搜索引擎会将网页的 HTML 代码去掉,剩下的文本内容,如正文、Meta 标签文本、锚文本、图片和视频注释等,可以进行排名处理,以便对排名的干扰较少。以下代码:

Apple 全球 14 家最著名的零售店

腾讯科技讯(云松)北京时间3月12日消息,据外媒报道,近日,全球知名杂志《福布斯》发布了苹果...

以上代码,服务器网页结构化后,去掉代码后去掉:“苹果全球第14家最有名的零售店,腾讯科技讯(云松)北京时间3月12日,据外媒报道,近日,世界著名杂志《福布斯》刊登了《苹果...》。

(2) 分词:通常用在中文搜索引擎中。因为中文和英文意思不同,所以中文的意思一般是词汇。有些词是一个词汇,或者多个词可以组成一个词汇。而且,还有中文单词之间没有分离,因此在中文搜索引擎中,需要根据字典或日常使用习惯,按词汇分句,建立按词汇索引的信息数据库。

比如上面这个网页“苹果全球最著名的14家零售店”,搜索引擎将字典分词调用为“苹果”、“全球”、“14”、“大”、“最”、“著名” ,“零售店”,然后根据一定的条件,建立由这些词索引的网页数据,然后进行一系列的排序程序。但在实际应用中,不仅以字典为依据,将日常搜索的统计数据和网页本身的词汇构成加入到分词中。

由于中文词汇太多,搜索引擎在判断网络词汇时需要借用词典进行分词。搜索引擎分词的准确性取决于词典的准确性和完整性。主要搜索引擎将建立独立的词典。这本词典不是静态的。不断增加新词,提出常用词。

打电话时安排更快。调用过程是将抓取到的网页文本与字典一一匹配,相当于查字典的过程。

需要说明的是,服务器在进行分词时,会以正反两种顺序对网页中的文本进行扫描,并利用词典中收录的长短词对网页文本进行多次分词。例如:“中国地图”通过字典的正向扫描分为“中国”和“地图”。这是最短的词汇。根据匹配最大的,可以分为“中国地图”,然后建立一个词对应的索引。物品。如图2.22和图2.23《中国地图》百度分词两个结果。

图2.22 《中国地图》百度分词结果

图2.23 《中国地图》百度分词结果

基于统计数据的分词是对字典分词的补充和优化。由于词典中新词匹配度低,搜索引擎不能很好地对新的关键词网页进行切分和索引,大大降低了搜索引擎搜索新关键词的能力。作为词典分词的补充,服务器可以根据每个词在网页中的出现频率。频率越高,说明这些词组成词,形成词汇统计数据库,在分词时调用匹配。例如,搜索“鞋子的理论是什么”。因为习近平主席提出的“鞋论”近期受到广泛关注,“鞋”四个字出现的频率

图2.24 《鞋子的理论是什么》百度分词结果

值得注意的是,每个搜索引擎的分词结果并不完全相同,满足用户需求的能力也不同,这主要取决于搜索引擎词典的丰富性和准确性。因此,不同搜索引擎对网页的切分结果并不完全相同,也是影响搜索结果的一个因素。SEOer对于分词所能做的,就是将常用的搜索词尽量组合起来,这样在搜索引擎分词的时候,就可以把常用的词转化为同一个词建立索引,获得更高的匹配度。.

(3)降噪去重:去除影响网页主要信息的无意义重复内容。因为网页信息通常收录较多的重复内容,如广告、页眉和底部信息等;以及文本内容网页中无意义的符号、文字等极大地浪费了搜索引擎资源,因此服务器会将这些无意义的内容从网页中移除。

在基于文本的网页中,有很多无意义的文本,如“的”、“了”、“啊”、“的”、“一个”、“那个”等,这些词占了很大的空间,但几乎没有人会搜索这些术语。为了减少无意义内容的干扰,搜索引擎会移除这些内容,即这些内容不会被索引为网页关键词。

由于互联网资源庞大,在网站之间转发内容会产生大量重复内容;在同一个网站中,同一个模板使得很多网页收录相同的内容,有的甚至占据了很大的空间。因此,搜索引擎抓取网页后,会检测是否为重复网页,如果一般不是收录;并且在同一个网站中,有很多收录重复内容的网页,比如同一个列表、广告、版权声明等,搜索引擎对这些网页的处理方式是将抓取到的内容与内容进行过滤比较在数据库中。如果相似度太高,则不会是收录,也不会为收录去掉相同的部分。

但是,由于互联网上的网页数量庞大,搜索引擎无法完全检测到每个网页。此外,很多内容是允许转载的,所以用户仍然可以搜索到很多相同的结果。但是网页的降噪是一个必要的过程,不仅可以减少资源的浪费,还可以提高排名的准确性。

(4)索引:搜索引擎使用网页中的词作为关键词,将便于查询的有序文件条目创建并存储在搜索引擎的索引数据库中。索引通常为分为正向索引和倒排索引两种索引。

正向索引是搜索引擎将抓取的网页。经过分词、去噪等操作后,以网页文件为单位映射网页文件中的关键词。简单的说,前向索引就是把一个网页文件的每一个关键词信息作为一个项存储,包括次数、频率、加粗和加黑,以及关键词信息的位置,以及根据程度遵循重要的Order 关键词。如图2.25是搜索引擎索引库前向索引的简化表,其中每个网页的所有关键词都进行了排序,其中比较重要的关键词是排名更高的位置。需要注意的是网页文件和关键词都有自己的编号,检索速度比较快,

倒排索引是以关键词为单位的搜索引擎到不同网页文件的映射。也就是说,搜索引擎使用关键词作为项目名称,内容是收录相同关键词的网页文件的顺序。用户常见的关键词搜索就是调用倒排索引。由于前向索引不能直接获得搜索结果排名,因此倒排索引是对前向索引的补充,也是用户搜索调用的关键索引。当用户搜索特定的关键词,例如“SEO”时,搜索引擎会调用以“SEO”为项名的索引项,然后返回按相关性排列的网页的处理结果给Query用户。如图2. 图26是搜索引擎索引库倒排索引的简化表。从表中可以看出,每个关键词对应了很多收录这个关键词的网页。是经过排序的,将大大提高搜索引擎的查询速度。

图2.25 搜索引擎索引库正行索引简化表

图2.26 搜索引擎索引库倒排索引简化表

搜索引擎索引库是整个搜索过程的基础,没有索引搜索引擎很难找到对应的内容。倒排索引更好的降低了关键词搜索网页的难度,大大提高了搜索引擎返回结果的速度。

(5)超链接分析:搜索引擎可以通过对网页链接的分析来计算网页的相关性。就像卖东西一样,所有卖家都会夸自己的东西好,网页也是如此。当然根据网页的性能来判断网页的排名不是很准确,因此搜索引擎希望通过网页以外的标准来衡量网页,在网页以外的标准中,最有利于搜索引擎掌握的就是超链接的数量。外部超链接的质量和质量以及网页导出链接的状态反映了网页的质量和关键词的相关性。这样的链接分析技术在所有搜索引擎中都存在,其中最著名的超链接分析是谷歌。中国公关技术,国内百度李彦宏提出的超链接分析技术,其他搜索引擎也有自己的超链接分析技术,但具体侧重点略有不同。

具体的超链接分析技术非常复杂,但最重要的原则是导入链接的数量、导入链接网页的质量、导入链接锚文本。例如,网页A有40个入站链接,其中30个以“SEO”为锚文本的链接;而网页B有30个入站链接和20个以“SEO”为锚文本的链接,一般情况下,网页A在关键词“SEO”排名结果较为理想。

由于超链接分析计算量大,计算时间长,当建立倒排索引时,超链接分析已经完成,对索引结果的排名有影响,也可以提高搜索引擎返回结果的速度.

(6)数据整合:搜索引擎对网页文件进行处理,将文件数据整理成各种格式,然后进行分类存储。因为网络文件的种类很多,比如Html、PPT、Word、Txt、Jpg 、Bmp、Swf、Mp3等格式,其中文本格式的网页文件可以很好地被搜索引擎识别和处理。描述性文本,对各类数据进行处理然后整合,存储在搜索引擎的数据库中,不同的数据格式分别存储,但在索引和排序时,往往会链接数据相关的内容,以确定其相关性和重要性,然后形成有利于搜索排名的最终数据库。

本文节选自金楠的《Seo搜索引擎实战解说》一书。更多信息请关注金楠博客或选择购买本书。 查看全部

网页qq抓取什么原理(

本文由金楠于2016-12-213:17发布在SEO网站优化阅读)

搜索引擎如何抓取和处理网页

本文由金楠发表于2016-12-2 13:17 SEO网站优化阅读:2554

服务器处理是对蜘蛛爬取的网页的处理。它是提高搜索准确性和用户体验的重要组成部分。和爬虫一样,是搜索引擎后台处理的一部分。

搜索引擎蜘蛛抓取的网页数据不能直接参与排名。由于数据量过大,如果直接被搜索者检索,大量相关网页的排名计算量非常大,不可能在一两秒内给用户提供答案。因此,搜索引擎会对抓取到的网页进行预处理,得到关键词的索引,相当于对网页上的每一个关键词进行预排序,用户在搜索时可以更快的获得搜索结果。.

服务器处理网页的工作通常包括网页结构化、分词、去噪和去重、索引、超链接分析、数据集成等。

(1)网页结构化:从网页中提取有用信息,去除HTML代码和足迹,剩下的文字信息就是服务器需要分析处理的数据。

搜索引擎蜘蛛抓取的网页收录了整个网页的所有信息。导航、类别列表、友情链接,甚至广告都会被抓取到搜索引擎。此类内容不能直接用于预排序处理。. 因此,搜索引擎会将网页的 HTML 代码去掉,剩下的文本内容,如正文、Meta 标签文本、锚文本、图片和视频注释等,可以进行排名处理,以便对排名的干扰较少。以下代码:

Apple 全球 14 家最著名的零售店

腾讯科技讯(云松)北京时间3月12日消息,据外媒报道,近日,全球知名杂志《福布斯》发布了苹果...

以上代码,服务器网页结构化后,去掉代码后去掉:“苹果全球第14家最有名的零售店,腾讯科技讯(云松)北京时间3月12日,据外媒报道,近日,世界著名杂志《福布斯》刊登了《苹果...》。

(2) 分词:通常用在中文搜索引擎中。因为中文和英文意思不同,所以中文的意思一般是词汇。有些词是一个词汇,或者多个词可以组成一个词汇。而且,还有中文单词之间没有分离,因此在中文搜索引擎中,需要根据字典或日常使用习惯,按词汇分句,建立按词汇索引的信息数据库。

比如上面这个网页“苹果全球最著名的14家零售店”,搜索引擎将字典分词调用为“苹果”、“全球”、“14”、“大”、“最”、“著名” ,“零售店”,然后根据一定的条件,建立由这些词索引的网页数据,然后进行一系列的排序程序。但在实际应用中,不仅以字典为依据,将日常搜索的统计数据和网页本身的词汇构成加入到分词中。

由于中文词汇太多,搜索引擎在判断网络词汇时需要借用词典进行分词。搜索引擎分词的准确性取决于词典的准确性和完整性。主要搜索引擎将建立独立的词典。这本词典不是静态的。不断增加新词,提出常用词。

打电话时安排更快。调用过程是将抓取到的网页文本与字典一一匹配,相当于查字典的过程。

需要说明的是,服务器在进行分词时,会以正反两种顺序对网页中的文本进行扫描,并利用词典中收录的长短词对网页文本进行多次分词。例如:“中国地图”通过字典的正向扫描分为“中国”和“地图”。这是最短的词汇。根据匹配最大的,可以分为“中国地图”,然后建立一个词对应的索引。物品。如图2.22和图2.23《中国地图》百度分词两个结果。

图2.22 《中国地图》百度分词结果

图2.23 《中国地图》百度分词结果

基于统计数据的分词是对字典分词的补充和优化。由于词典中新词匹配度低,搜索引擎不能很好地对新的关键词网页进行切分和索引,大大降低了搜索引擎搜索新关键词的能力。作为词典分词的补充,服务器可以根据每个词在网页中的出现频率。频率越高,说明这些词组成词,形成词汇统计数据库,在分词时调用匹配。例如,搜索“鞋子的理论是什么”。因为习近平主席提出的“鞋论”近期受到广泛关注,“鞋”四个字出现的频率

图2.24 《鞋子的理论是什么》百度分词结果

值得注意的是,每个搜索引擎的分词结果并不完全相同,满足用户需求的能力也不同,这主要取决于搜索引擎词典的丰富性和准确性。因此,不同搜索引擎对网页的切分结果并不完全相同,也是影响搜索结果的一个因素。SEOer对于分词所能做的,就是将常用的搜索词尽量组合起来,这样在搜索引擎分词的时候,就可以把常用的词转化为同一个词建立索引,获得更高的匹配度。.

(3)降噪去重:去除影响网页主要信息的无意义重复内容。因为网页信息通常收录较多的重复内容,如广告、页眉和底部信息等;以及文本内容网页中无意义的符号、文字等极大地浪费了搜索引擎资源,因此服务器会将这些无意义的内容从网页中移除。

在基于文本的网页中,有很多无意义的文本,如“的”、“了”、“啊”、“的”、“一个”、“那个”等,这些词占了很大的空间,但几乎没有人会搜索这些术语。为了减少无意义内容的干扰,搜索引擎会移除这些内容,即这些内容不会被索引为网页关键词。

由于互联网资源庞大,在网站之间转发内容会产生大量重复内容;在同一个网站中,同一个模板使得很多网页收录相同的内容,有的甚至占据了很大的空间。因此,搜索引擎抓取网页后,会检测是否为重复网页,如果一般不是收录;并且在同一个网站中,有很多收录重复内容的网页,比如同一个列表、广告、版权声明等,搜索引擎对这些网页的处理方式是将抓取到的内容与内容进行过滤比较在数据库中。如果相似度太高,则不会是收录,也不会为收录去掉相同的部分。

但是,由于互联网上的网页数量庞大,搜索引擎无法完全检测到每个网页。此外,很多内容是允许转载的,所以用户仍然可以搜索到很多相同的结果。但是网页的降噪是一个必要的过程,不仅可以减少资源的浪费,还可以提高排名的准确性。

(4)索引:搜索引擎使用网页中的词作为关键词,将便于查询的有序文件条目创建并存储在搜索引擎的索引数据库中。索引通常为分为正向索引和倒排索引两种索引。

正向索引是搜索引擎将抓取的网页。经过分词、去噪等操作后,以网页文件为单位映射网页文件中的关键词。简单的说,前向索引就是把一个网页文件的每一个关键词信息作为一个项存储,包括次数、频率、加粗和加黑,以及关键词信息的位置,以及根据程度遵循重要的Order 关键词。如图2.25是搜索引擎索引库前向索引的简化表,其中每个网页的所有关键词都进行了排序,其中比较重要的关键词是排名更高的位置。需要注意的是网页文件和关键词都有自己的编号,检索速度比较快,

倒排索引是以关键词为单位的搜索引擎到不同网页文件的映射。也就是说,搜索引擎使用关键词作为项目名称,内容是收录相同关键词的网页文件的顺序。用户常见的关键词搜索就是调用倒排索引。由于前向索引不能直接获得搜索结果排名,因此倒排索引是对前向索引的补充,也是用户搜索调用的关键索引。当用户搜索特定的关键词,例如“SEO”时,搜索引擎会调用以“SEO”为项名的索引项,然后返回按相关性排列的网页的处理结果给Query用户。如图2. 图26是搜索引擎索引库倒排索引的简化表。从表中可以看出,每个关键词对应了很多收录这个关键词的网页。是经过排序的,将大大提高搜索引擎的查询速度。

图2.25 搜索引擎索引库正行索引简化表

图2.26 搜索引擎索引库倒排索引简化表

搜索引擎索引库是整个搜索过程的基础,没有索引搜索引擎很难找到对应的内容。倒排索引更好的降低了关键词搜索网页的难度,大大提高了搜索引擎返回结果的速度。

(5)超链接分析:搜索引擎可以通过对网页链接的分析来计算网页的相关性。就像卖东西一样,所有卖家都会夸自己的东西好,网页也是如此。当然根据网页的性能来判断网页的排名不是很准确,因此搜索引擎希望通过网页以外的标准来衡量网页,在网页以外的标准中,最有利于搜索引擎掌握的就是超链接的数量。外部超链接的质量和质量以及网页导出链接的状态反映了网页的质量和关键词的相关性。这样的链接分析技术在所有搜索引擎中都存在,其中最著名的超链接分析是谷歌。中国公关技术,国内百度李彦宏提出的超链接分析技术,其他搜索引擎也有自己的超链接分析技术,但具体侧重点略有不同。

具体的超链接分析技术非常复杂,但最重要的原则是导入链接的数量、导入链接网页的质量、导入链接锚文本。例如,网页A有40个入站链接,其中30个以“SEO”为锚文本的链接;而网页B有30个入站链接和20个以“SEO”为锚文本的链接,一般情况下,网页A在关键词“SEO”排名结果较为理想。

由于超链接分析计算量大,计算时间长,当建立倒排索引时,超链接分析已经完成,对索引结果的排名有影响,也可以提高搜索引擎返回结果的速度.

(6)数据整合:搜索引擎对网页文件进行处理,将文件数据整理成各种格式,然后进行分类存储。因为网络文件的种类很多,比如Html、PPT、Word、Txt、Jpg 、Bmp、Swf、Mp3等格式,其中文本格式的网页文件可以很好地被搜索引擎识别和处理。描述性文本,对各类数据进行处理然后整合,存储在搜索引擎的数据库中,不同的数据格式分别存储,但在索引和排序时,往往会链接数据相关的内容,以确定其相关性和重要性,然后形成有利于搜索排名的最终数据库。

本文节选自金楠的《Seo搜索引擎实战解说》一书。更多信息请关注金楠博客或选择购买本书。

网页qq抓取什么原理(一下实现简单爬虫功能的示例python爬虫实战之最简单的网页爬虫教程)

网站优化 • 优采云 发表了文章 • 0 个评论 • 109 次浏览 • 2021-11-04 19:01

既然这篇文章文章讲的是Python搭建网络爬虫的原理分析,那我先给大家介绍一下Python中爬虫的选择文章:

Python实现简单爬虫功能示例

python爬虫实战最简单的网络爬虫教程

网络爬虫是当今最常用的系统之一。最流行的例子是 Google 使用爬虫从所有 网站 采集信息。除了搜索引擎,新闻网站还需要爬虫来聚合数据源。看来只要想聚合很多信息,就可以考虑使用爬虫。

构建网络爬虫有很多因素,尤其是当您要扩展系统时。这就是为什么这已经成为最流行的系统设计面试问题之一。在这个文章中,我们将讨论从基础爬虫到大型爬虫的话题,讨论面试中可能遇到的各种问题。

1-基本解决方案

如何构建一个基本的网络爬虫?

在系统设计面试之前,我们已经讲过“系统设计面试前你需要知道的八件事”,就是从简单的事情开始。让我们专注于构建一个在单线程上运行的基本网络爬虫。通过这个简单的解决方案,我们可以继续优化。

爬取单个网页,我们只需要向对应的URL发起HTTP GET请求,解析响应数据,这是爬虫的核心。考虑到这一点,一个基本的网络爬虫可以这样工作:

从收录我们要爬取的所有 网站 的 URL 池开始。

对于每个 URL,发出 HTTP GET 请求以获取网页的内容。

解析内容(通常是 HTML)并提取我们想要抓取的潜在 URL。

向池中添加新 URL 并继续爬行。

根据具体问题,有时我们可能有一个单独的系统来生成抓取网址。例如,一个程序可以持续监控RSS订阅,并且对于每一个新的文章,都可以将URL添加到爬取池中。

2 尺度问题

众所周知,任何系统在扩展后都会面临一系列问题。在网络爬虫中,当系统扩展到多台机器时,会出现很多问题。

在跳到下一节之前,请花几分钟思考一下分布式网络爬虫的瓶颈以及如何解决这个问题。在本文章的其余部分,我们将讨论解决方案的主要问题。

3-爬行频率

你多久爬一次 网站?

这听起来可能没什么大不了的,除非系统达到一定规模并且您需要非常新鲜的内容。例如,如果你想获取最近一小时的最新消息,爬虫可能需要保持每小时爬一次新闻网站。但是有什么问题呢?

对于一些小的网站,他们的服务器可能无法处理如此频繁的请求。一种方法是跟踪每个站点的robot.txt。对于不知道robot.txt是什么的人来说,这基本上是网站与网络爬虫通信的标准。它可以指定哪些文件不应该被抓取,大多数网络爬虫都遵循这个配置。另外,你可以为不同的网站设置不同的爬取频率。通常,每天只需要爬取几次网站。

4-重复数据删除

在机器上,您可以将 URL 池保留在内存中并删除重复条目。然而,分布式系统中的事情变得更加复杂。基本上,多个爬虫可以从不同的网页中提取同一个网址,并且都想把这个网址加入到网址池中。当然,多次爬取同一个页面是没有意义的。那么我们如何重复这些网址呢?

一种常用的方法是使用布隆过滤器。简而言之,Bloom Filter 是一个节省空间的系统,它允许您测试元素是否在集合中。但是,它可能有误报。换句话说,如果布隆过滤器可以告诉你一个 URL 肯定不在池中,或者可能在池中。

为了简要说明布隆过滤器的工作原理,空布隆过滤器是 m 位(所有 0) 位数组。还有 k 个哈希函数将每个元素映射到 m 位 A。所以当我们添加一个新元素(URL ) 在 Bloom filter 中,我们会从 hash 函数中得到 k 位,并将它们都设置为 1. 所以当我们检查一个元素时,我们首先得到 k 位。如果其中任何一个不为 1,我们立即知道该元素不存在。但是,如果所有 k 位都为 1,则这可能来自其他几个元素的组合。

布隆过滤器是一种非常常用的技术,它是网络爬虫中去除重复网址的完美解决方案。

5-解析

从网站得到响应数据后,下一步就是解析数据(通常是HTML),提取出我们关心的信息。这听起来很简单,但要让它健壮可能很难。

我们面临的挑战是,你总会在 HTML 代码中发现奇怪的标签、URL 等,并且很难覆盖所有的边界条件。例如,当 HTML 收录非 Unicode 字符时,您可能需要处理编码和解码问题。此外,当网页中收录图片、视频甚至PDF文件时,也会引起奇怪的行为。

另外,有些网页像AngularJS一样是通过Javascript来渲染的,你的爬虫可能无法获取到任何内容。

我想说,没有灵丹妙药,就不可能为所有网页制作完美而强大的爬虫。您需要进行大量的稳健性测试以确保它按预期工作。

总结

有很多有趣的话题我还没有触及,但我想提一下其中的一些,以便您可以思考它们。一件事是检测循环。很多网站都收录链接,比如A->B->C->A,你的爬虫可能会一直跑。想想如何解决这个问题?

另一个问题是 DNS 查找。当系统扩展到一定程度时,DNS 查找可能会成为瓶颈,您可能需要构建自己的 DNS 服务器。

与许多其他系统类似,扩展的网络爬虫可能比构建单机版本困难得多,并且可以在系统设计面试中讨论很多事情。尝试从一些幼稚的解决方案开始并继续优化它,这会使事情变得比看起来更容易。

以上是我们总结的关于网络爬虫的相关文章内容。如果你还有什么想知道的,可以在下方评论区讨论。感谢您对 的支持。 查看全部

网页qq抓取什么原理(一下实现简单爬虫功能的示例python爬虫实战之最简单的网页爬虫教程)

既然这篇文章文章讲的是Python搭建网络爬虫的原理分析,那我先给大家介绍一下Python中爬虫的选择文章:

Python实现简单爬虫功能示例

python爬虫实战最简单的网络爬虫教程

网络爬虫是当今最常用的系统之一。最流行的例子是 Google 使用爬虫从所有 网站 采集信息。除了搜索引擎,新闻网站还需要爬虫来聚合数据源。看来只要想聚合很多信息,就可以考虑使用爬虫。

构建网络爬虫有很多因素,尤其是当您要扩展系统时。这就是为什么这已经成为最流行的系统设计面试问题之一。在这个文章中,我们将讨论从基础爬虫到大型爬虫的话题,讨论面试中可能遇到的各种问题。

1-基本解决方案

如何构建一个基本的网络爬虫?

在系统设计面试之前,我们已经讲过“系统设计面试前你需要知道的八件事”,就是从简单的事情开始。让我们专注于构建一个在单线程上运行的基本网络爬虫。通过这个简单的解决方案,我们可以继续优化。

爬取单个网页,我们只需要向对应的URL发起HTTP GET请求,解析响应数据,这是爬虫的核心。考虑到这一点,一个基本的网络爬虫可以这样工作:

从收录我们要爬取的所有 网站 的 URL 池开始。

对于每个 URL,发出 HTTP GET 请求以获取网页的内容。

解析内容(通常是 HTML)并提取我们想要抓取的潜在 URL。

向池中添加新 URL 并继续爬行。

根据具体问题,有时我们可能有一个单独的系统来生成抓取网址。例如,一个程序可以持续监控RSS订阅,并且对于每一个新的文章,都可以将URL添加到爬取池中。

2 尺度问题

众所周知,任何系统在扩展后都会面临一系列问题。在网络爬虫中,当系统扩展到多台机器时,会出现很多问题。

在跳到下一节之前,请花几分钟思考一下分布式网络爬虫的瓶颈以及如何解决这个问题。在本文章的其余部分,我们将讨论解决方案的主要问题。

3-爬行频率

你多久爬一次 网站?

这听起来可能没什么大不了的,除非系统达到一定规模并且您需要非常新鲜的内容。例如,如果你想获取最近一小时的最新消息,爬虫可能需要保持每小时爬一次新闻网站。但是有什么问题呢?

对于一些小的网站,他们的服务器可能无法处理如此频繁的请求。一种方法是跟踪每个站点的robot.txt。对于不知道robot.txt是什么的人来说,这基本上是网站与网络爬虫通信的标准。它可以指定哪些文件不应该被抓取,大多数网络爬虫都遵循这个配置。另外,你可以为不同的网站设置不同的爬取频率。通常,每天只需要爬取几次网站。

4-重复数据删除

在机器上,您可以将 URL 池保留在内存中并删除重复条目。然而,分布式系统中的事情变得更加复杂。基本上,多个爬虫可以从不同的网页中提取同一个网址,并且都想把这个网址加入到网址池中。当然,多次爬取同一个页面是没有意义的。那么我们如何重复这些网址呢?

一种常用的方法是使用布隆过滤器。简而言之,Bloom Filter 是一个节省空间的系统,它允许您测试元素是否在集合中。但是,它可能有误报。换句话说,如果布隆过滤器可以告诉你一个 URL 肯定不在池中,或者可能在池中。

为了简要说明布隆过滤器的工作原理,空布隆过滤器是 m 位(所有 0) 位数组。还有 k 个哈希函数将每个元素映射到 m 位 A。所以当我们添加一个新元素(URL ) 在 Bloom filter 中,我们会从 hash 函数中得到 k 位,并将它们都设置为 1. 所以当我们检查一个元素时,我们首先得到 k 位。如果其中任何一个不为 1,我们立即知道该元素不存在。但是,如果所有 k 位都为 1,则这可能来自其他几个元素的组合。

布隆过滤器是一种非常常用的技术,它是网络爬虫中去除重复网址的完美解决方案。

5-解析

从网站得到响应数据后,下一步就是解析数据(通常是HTML),提取出我们关心的信息。这听起来很简单,但要让它健壮可能很难。

我们面临的挑战是,你总会在 HTML 代码中发现奇怪的标签、URL 等,并且很难覆盖所有的边界条件。例如,当 HTML 收录非 Unicode 字符时,您可能需要处理编码和解码问题。此外,当网页中收录图片、视频甚至PDF文件时,也会引起奇怪的行为。

另外,有些网页像AngularJS一样是通过Javascript来渲染的,你的爬虫可能无法获取到任何内容。

我想说,没有灵丹妙药,就不可能为所有网页制作完美而强大的爬虫。您需要进行大量的稳健性测试以确保它按预期工作。

总结

有很多有趣的话题我还没有触及,但我想提一下其中的一些,以便您可以思考它们。一件事是检测循环。很多网站都收录链接,比如A->B->C->A,你的爬虫可能会一直跑。想想如何解决这个问题?

另一个问题是 DNS 查找。当系统扩展到一定程度时,DNS 查找可能会成为瓶颈,您可能需要构建自己的 DNS 服务器。

与许多其他系统类似,扩展的网络爬虫可能比构建单机版本困难得多,并且可以在系统设计面试中讨论很多事情。尝试从一些幼稚的解决方案开始并继续优化它,这会使事情变得比看起来更容易。

以上是我们总结的关于网络爬虫的相关文章内容。如果你还有什么想知道的,可以在下方评论区讨论。感谢您对 的支持。

网页qq抓取什么原理(传统爬虫从当前页面上抽取新的URL放入队列,,)

网站优化 • 优采云 发表了文章 • 0 个评论 • 52 次浏览 • 2021-11-04 17:15

聊聊爬虫的工作原理和三大模块!传统爬虫从一个或多个初始网页的网址开始,获取初始网页上的网址,在网页抓取过程中不断从当前页面中提取新的网址放入队列中,直到某个停止条件系统的满足。聚焦爬虫的工作流程比较复杂。需要按照一定的网页分析算法过滤与主题无关的链接,保留有用的链接,放入URL队列等待被抓取。

然后,它会根据一定的搜索策略从队列中选择下一个要抓取的网页的网址,并重复上述过程,直到达到系统的某个条件时停止。另外,爬虫爬过的所有网页都会被系统存储起来,进行一定的分析、过滤、索引,以备以后查询检索;因此,一个完整的爬虫一般收录以下三个模块:

一、网络请求模块

二、 爬行过程控制模块

三、内容分析提取模块

网络请求

我们常说的爬虫其实就是一堆http(s)请求,找到要爬取的链接,然后发送一个请求包得到一个返回包。当然,h5 中也有 HTTP 长连接(keep-alive)或者基于流的。网络套接字协议。

过程控制

所谓爬取过程,是指使用规则进行爬取的顺序。在小爬虫任务的情况下,爬虫的过程不会太麻烦。很多爬虫框架已经帮你做了,比如scrapy,你只需要自己实现解析代码即可。

内容分析提取

请求头的 Accept-Encoding 字段表示浏览器告诉服务器它支持的压缩算法(最新的是 gzip)。如果服务端开启压缩,响应体返回时会被压缩,爬虫需要自己解压。

黑洞代理IP平台专门提供代理IP,非常适合爬虫工作。高效稳定,安全易操作。是爬虫首选的代理IP服务商。 查看全部

网页qq抓取什么原理(传统爬虫从当前页面上抽取新的URL放入队列,,)

聊聊爬虫的工作原理和三大模块!传统爬虫从一个或多个初始网页的网址开始,获取初始网页上的网址,在网页抓取过程中不断从当前页面中提取新的网址放入队列中,直到某个停止条件系统的满足。聚焦爬虫的工作流程比较复杂。需要按照一定的网页分析算法过滤与主题无关的链接,保留有用的链接,放入URL队列等待被抓取。

然后,它会根据一定的搜索策略从队列中选择下一个要抓取的网页的网址,并重复上述过程,直到达到系统的某个条件时停止。另外,爬虫爬过的所有网页都会被系统存储起来,进行一定的分析、过滤、索引,以备以后查询检索;因此,一个完整的爬虫一般收录以下三个模块:

一、网络请求模块

二、 爬行过程控制模块

三、内容分析提取模块

网络请求

我们常说的爬虫其实就是一堆http(s)请求,找到要爬取的链接,然后发送一个请求包得到一个返回包。当然,h5 中也有 HTTP 长连接(keep-alive)或者基于流的。网络套接字协议。

过程控制

所谓爬取过程,是指使用规则进行爬取的顺序。在小爬虫任务的情况下,爬虫的过程不会太麻烦。很多爬虫框架已经帮你做了,比如scrapy,你只需要自己实现解析代码即可。

内容分析提取

请求头的 Accept-Encoding 字段表示浏览器告诉服务器它支持的压缩算法(最新的是 gzip)。如果服务端开启压缩,响应体返回时会被压缩,爬虫需要自己解压。

黑洞代理IP平台专门提供代理IP,非常适合爬虫工作。高效稳定,安全易操作。是爬虫首选的代理IP服务商。

网页qq抓取什么原理(襄阳网络营销:网络爬虫是什么?爬虫深度优先和优先)

网站优化 • 优采云 发表了文章 • 0 个评论 • 63 次浏览 • 2021-11-04 17:14

今天向阳网络营销就带大家了解一下:什么是网络爬虫?网络爬虫的原理

什么是爬虫

爬虫有很多名称,如网络机器人、蜘蛛等,这是一个无需人工干预即可自动进行一系列网络事务管理的软件系统。网络爬虫是一种机器人。他们会递归遍历各种信息web网站,得到第一个网页页面,然后得到所有偏向哪个页面页面的网页页面。派生。互联网百度搜索引擎应用爬虫在网络上徘徊,把遇到的所有文本文档都拉出来。然后解析此文本文档,生成可搜索的数据库查询。简单的说,网络爬虫就是百度搜索引擎浏览你的网站,所以网站收录就是你的网站的一种内容采集软件。例如,

网络爬虫的原理

网络爬虫是指按照一定的规则自动爬取网络上的程序(模拟手动登录网页的方式)。简单的说,就是你在网上看到的页面内容被获取并存储。网络爬虫的爬取策略分为深度优先和广度优先。下图展示了从A到B到D到E到C到F的深度优先遍历方法(ABDECF)和广度优先遍历方法ABCDEF。

网络爬虫的基本结构和工作流程

网络爬虫的基本工作流程如下:

1.首先选择一些精心挑选的种子网址;

2.将这些URL放入URL队列进行抓取;

3. 从待爬取的URL队列中取出待爬取的URL,解析DNS,获取主机IP,下载该URL对应的网页,并保存到下载的网页库中。另外,将这些 URL 放入爬取的 URL 队列中。

4.对爬取的URL队列中的URL进行解析,分析其中的其他URL,将这些URL放入URL队列进行爬取,从而进入下一个循环。

以上几点就是今天向阳网络营销为大家思考的问题:什么是网络爬虫?网络爬虫的原理。希望对网站 想成为网络营销公司的企业有所帮助。我司是襄阳网站建筑公司,高端网站定制开发公司

上一篇:网站的制作过程:网站的制作基本步骤 查看全部

网页qq抓取什么原理(襄阳网络营销:网络爬虫是什么?爬虫深度优先和优先)

今天向阳网络营销就带大家了解一下:什么是网络爬虫?网络爬虫的原理

什么是爬虫

爬虫有很多名称,如网络机器人、蜘蛛等,这是一个无需人工干预即可自动进行一系列网络事务管理的软件系统。网络爬虫是一种机器人。他们会递归遍历各种信息web网站,得到第一个网页页面,然后得到所有偏向哪个页面页面的网页页面。派生。互联网百度搜索引擎应用爬虫在网络上徘徊,把遇到的所有文本文档都拉出来。然后解析此文本文档,生成可搜索的数据库查询。简单的说,网络爬虫就是百度搜索引擎浏览你的网站,所以网站收录就是你的网站的一种内容采集软件。例如,

网络爬虫的原理

网络爬虫是指按照一定的规则自动爬取网络上的程序(模拟手动登录网页的方式)。简单的说,就是你在网上看到的页面内容被获取并存储。网络爬虫的爬取策略分为深度优先和广度优先。下图展示了从A到B到D到E到C到F的深度优先遍历方法(ABDECF)和广度优先遍历方法ABCDEF。

网络爬虫的基本结构和工作流程

网络爬虫的基本工作流程如下:

1.首先选择一些精心挑选的种子网址;

2.将这些URL放入URL队列进行抓取;

3. 从待爬取的URL队列中取出待爬取的URL,解析DNS,获取主机IP,下载该URL对应的网页,并保存到下载的网页库中。另外,将这些 URL 放入爬取的 URL 队列中。

4.对爬取的URL队列中的URL进行解析,分析其中的其他URL,将这些URL放入URL队列进行爬取,从而进入下一个循环。

以上几点就是今天向阳网络营销为大家思考的问题:什么是网络爬虫?网络爬虫的原理。希望对网站 想成为网络营销公司的企业有所帮助。我司是襄阳网站建筑公司,高端网站定制开发公司

上一篇:网站的制作过程:网站的制作基本步骤

网页qq抓取什么原理(网页数据采集的一个重要分支的工作原理)

网站优化 • 优采云 发表了文章 • 0 个评论 • 150 次浏览 • 2021-11-04 13:04

摘要:搜索引擎爬虫是网页数据的一个重要分支采集,通常是指搜索引擎爬虫根据每个网页上的超链接,到达每个网页并索引整个网页而形成的一个无形的关联网络。 , 然后将快照和关键信息保存在数据库中,以便用户在搜索时根据关键词进行匹配显示相关信息。

搜索引擎爬虫是网页数据的一个重要分支采集,通常是指搜索引擎爬虫根据每个网页上的超链接,到达每个网页并索引整个网页而形成的一个无形的关联网络,然后在数据库中保存快照和关键信息,以便用户在搜索时根据关键词匹配并显示相关信息。下面,优采云采集器将详细介绍网络爬虫的种类、策略和工作原理。

网络爬虫的工作原理

一般来说,爬虫也指搜索引擎之类的爬虫。那么爬虫是如何抓取采集网页的呢?百度、谷歌等巨型爬虫目前基于云计算,由数千台计算机组成。一个庞大的爬虫系统,所以它的原理比较复杂,有很多技术难点,但是就其基本原理来说,都是一样的。

上图是一个基本示意图,展示了爬虫是如何从一个网页爬到另一个网页的。首先,从互联网页面中仔细选择一部分网页,并将这些网页的链接地址作为种子网址,然后将这些种子网址放入要抓取的网址队列中,爬虫从网址队列中读取依次被抓取,并通过DNS解析URL,将链接地址转换为网站服务器对应的IP地址,然后与网页的相对路径进行比较,将名称交给web下载器,负责下载页面的内容。

在爬虫系统中,要爬取的URL队列是一个非常重要的部分。URL队列中要爬取的URL的顺序也是一个很重要的问题。主要的采集策略如下:

1、深度优先策略

深度优先遍历策略类似于家族的继承策略,典型的是封建皇帝的继承,通常是长子。如果长子死了,大孙子的优先级大于次子的优先级(这就是为什么要仔细分析的原因)。大孙子去世了,所以老二继承,这种继承上的优先关系也称为深度优先策略。(从这点我们可以理解蜘蛛爬行的栏目页面的顺序),主要体现在对一个站点采集的深度阅读。

2、宽度优先策略

宽度优先也称为广度优先,或层次优先。例如,当我们给祖父母、父母和同龄人上茶时,我们首先给最年长的祖父茶,然后是父亲,最后是同龄人。这主要体现在爬取多个不同的网站。

这两种策略决定了爬虫采集的覆盖范围和深度。一般来说,搜索引擎爬虫同时具备这两种策略。具体操作策略根据网站的不同而有所不同。

网络爬虫的类型

就像社会上有各种各样的职业和分工,大型履带系统内部也有不同的分工。这将爬虫分为几种类型:

1、新的网络爬虫

这个爬虫专门负责寻找没有采集的新网页,或者新的网站。

2、 常规爬虫

这种爬虫主要负责采集更新更快、内容更多网站,它们会保存这些网页的URL,并定期去采集看看有没有内容更新。

网络爬虫后期数据处理方法

当然,爬虫在删除网页采集后,还需要对网页内容进行复杂的后期组织,包括:网页权重计算、重复内容过滤,甚至URL有效性更新。在实践中,搜索引擎爬虫使用的技术非常复杂,往往收录很多复杂的数学原理。同时,随着互联网的爆发式发展,爬虫技术也在不断完善,变得更加智能和强大。 查看全部

网页qq抓取什么原理(网页数据采集的一个重要分支的工作原理)

摘要:搜索引擎爬虫是网页数据的一个重要分支采集,通常是指搜索引擎爬虫根据每个网页上的超链接,到达每个网页并索引整个网页而形成的一个无形的关联网络。 , 然后将快照和关键信息保存在数据库中,以便用户在搜索时根据关键词进行匹配显示相关信息。

搜索引擎爬虫是网页数据的一个重要分支采集,通常是指搜索引擎爬虫根据每个网页上的超链接,到达每个网页并索引整个网页而形成的一个无形的关联网络,然后在数据库中保存快照和关键信息,以便用户在搜索时根据关键词匹配并显示相关信息。下面,优采云采集器将详细介绍网络爬虫的种类、策略和工作原理。

网络爬虫的工作原理

一般来说,爬虫也指搜索引擎之类的爬虫。那么爬虫是如何抓取采集网页的呢?百度、谷歌等巨型爬虫目前基于云计算,由数千台计算机组成。一个庞大的爬虫系统,所以它的原理比较复杂,有很多技术难点,但是就其基本原理来说,都是一样的。

上图是一个基本示意图,展示了爬虫是如何从一个网页爬到另一个网页的。首先,从互联网页面中仔细选择一部分网页,并将这些网页的链接地址作为种子网址,然后将这些种子网址放入要抓取的网址队列中,爬虫从网址队列中读取依次被抓取,并通过DNS解析URL,将链接地址转换为网站服务器对应的IP地址,然后与网页的相对路径进行比较,将名称交给web下载器,负责下载页面的内容。

在爬虫系统中,要爬取的URL队列是一个非常重要的部分。URL队列中要爬取的URL的顺序也是一个很重要的问题。主要的采集策略如下:

1、深度优先策略

深度优先遍历策略类似于家族的继承策略,典型的是封建皇帝的继承,通常是长子。如果长子死了,大孙子的优先级大于次子的优先级(这就是为什么要仔细分析的原因)。大孙子去世了,所以老二继承,这种继承上的优先关系也称为深度优先策略。(从这点我们可以理解蜘蛛爬行的栏目页面的顺序),主要体现在对一个站点采集的深度阅读。

2、宽度优先策略

宽度优先也称为广度优先,或层次优先。例如,当我们给祖父母、父母和同龄人上茶时,我们首先给最年长的祖父茶,然后是父亲,最后是同龄人。这主要体现在爬取多个不同的网站。

这两种策略决定了爬虫采集的覆盖范围和深度。一般来说,搜索引擎爬虫同时具备这两种策略。具体操作策略根据网站的不同而有所不同。

网络爬虫的类型

就像社会上有各种各样的职业和分工,大型履带系统内部也有不同的分工。这将爬虫分为几种类型:

1、新的网络爬虫

这个爬虫专门负责寻找没有采集的新网页,或者新的网站。

2、 常规爬虫

这种爬虫主要负责采集更新更快、内容更多网站,它们会保存这些网页的URL,并定期去采集看看有没有内容更新。

网络爬虫后期数据处理方法

当然,爬虫在删除网页采集后,还需要对网页内容进行复杂的后期组织,包括:网页权重计算、重复内容过滤,甚至URL有效性更新。在实践中,搜索引擎爬虫使用的技术非常复杂,往往收录很多复杂的数学原理。同时,随着互联网的爆发式发展,爬虫技术也在不断完善,变得更加智能和强大。

网页qq抓取什么原理(如何解决一个的网页核心内容?(最优)总结(二))

网站优化 • 优采云 发表了文章 • 0 个评论 • 105 次浏览 • 2021-11-02 17:18

目录选择的最佳总结

正文|李小飞

来源:python技术《id:pythonall》

每个人都必须熟悉爬虫程序。随便写一个获取网页信息,甚至可以根据请求自动生成python脚本[1]。

最近在网上遇到一个爬虫项目,需要爬取文章。感觉没什么特别的,但是问题是没有抓取范围的限制,也就是说没有清晰的页面结构。

对于一个页面来说,除了核心的文章内容,还有head、tail、左右列表列等等。有的页框使用div布局,有的使用table。即使两者都使用div,less网站的样式和布局是不同的。

但问题必须解决。我想,既然搜索引擎抓取了各种网页的核心内容,我们应该也能做到。拿起蟒蛇做吧!

各种尝试

如何解决?

生成pdf

开始想到一个比较棘手的方法,就是使用工具(wkhtmltopdf[2])生成目标网页的pdf文件。

好处是不需要关心页面的具体形式,就像给页面拍照一样,文章结构完整。

虽然可以在源码级别检索pdf,但是生成pdf有很多缺点:

计算资源消耗大,效率低,错误率高,体积过大。

几万条数据已经两百多g了,如果数据量上来存储,那就是大问题了。

提取 文章 内容

在不生成pdf的情况下,有一种简单的方法可以通过xpath[3]提取页面上的所有文本。

但是内容会失去结构,可读性会很差。更糟糕的是,网页上还有很多不相关的内容,比如侧边栏、广告、相关链接等,也会被提取出来,影响内容的准确性。

为了保证一定的结构和识别核心内容,只能识别和提取文章部分的结构。像搜索引擎一样学习,就是想办法识别页面的核心内容。

我们知道,一般情况下,页面的核心内容(比如文章部分)文字比较集中,可以从这个地方开始分析。

所以我写了一段代码。我使用scrapy[4] 作为爬虫框架。这里只截取了提取文章部分的代码:

divs = response.xpath("body//div") sel = none maxvalue = 0 for d in divs: ds = len(d.xpath(".//div")) ps = len(d.xpath(".//p")) value = ps - ds if value > maxvalue: sel = { "node": d, "value": value } maxvalue = value print("".join(sel['node'].getall()))

简单明了,测试几页真的很好。

但是,在提取大量页面时,发现很多页面无法提取数据。仔细一看,发现有两种情况。

再次调整策略,不再区分div,查看所有元素。

另外,更喜欢p,然后在此基础上看更少的div。调整后的代码如下:

divs = response.xpath("body//*") sels = [] maxvalue = 0 for d in divs: ds = len(d.xpath(".//div")) ps = len(d.xpath(".//p")) if ps >= maxvalue: sel = { "node": d, "ps": ps, "ds": ds } maxvalue = ps sels.append(sel) sels.sort(lambda x: x.ds) sel = sels[0] print("".join(sel['node'].getall()))

经过这次修改,确实在一定程度上弥补了之前的问题,但是引入了一个比较麻烦的问题。

发现的文章主体不稳定,特别容易受到其他部分的一些p的影响。

选最好的

由于不适合直接计算,需要重新设计算法。

发现文字集中的地方往往是文章的主体。前面的方法没有考虑这个,而是机械地找到最大的p。

还有一点,网页结构是一个dom树[6]

那么离标签p越近,就越有可能成为文章的主题,也就是说离p越近的节点权重应该越大,离p越远的节点权重就越大p 时间,但权重也应该更小。

经过反复试验,最终代码如下:

def find(node, sel): value = 0 for n in node.xpath("*"): if n.xpath("local-name()").get() == "p": t = "".join([s.strip() for s in (n.xpath('text()').getall() + n.xpath("*/text()").getall())]) value += len(t) else: value += find(n, a)*0.5 if value > sel["value"]: sel["node"] = node sel["value"] = value return value sel = { 'value': 0, 'node': none } find(response.xpath("body"), sel)

经过这次改造,效果特别好。

为什么?其实就是利用了密度原理,即离中心越近,密度越高,离中心越远,密度呈指数下降,这样就可以滤除密度中心。

50%的斜率是如何得到的?

其实是通过实验确定的。一开始,我把它设置为90%,但结果是body节点总是最好的,因为body收录了所有的文本内容。

经过反复实验,确定 50% 是一个更好的值。如果它不适合您的应用程序,您可以进行调整。

总结

在描述了我如何选择文章 主题的方法后,我没有意识到它实际上是一个非常简单的方法。而这次解题的经历,让我感受到了数学的魅力。

我一直认为,只要理解了常规的处理问题的方式,处理日常编程就足够了。当遇到不确定的问题,又没有办法提取出简单的问题模型时,常规思维显然是不行的。

因此,我们通常应该看看一些数学上很强的方法来解决不确定的问题,以提高我们的编程适应性,扩大我们的技能范围。

我希望这篇短文能对你有所启发。欢迎在留言区交流讨论,大展身手!

参考

[1]

卷曲到蟒蛇:

[2]

wkhtmltopdf:

[3]

路径:

[4]

刮擦:

[5]

查询:

[6]

dom 树:%20tree/6067246

以上就是python实现精准搜索和提取网页核心内容的详细过程。关于python搜索和提取网页内容的更多信息,请关注其他相关文章!

如果需要了解更多python教程,分享python实现精准搜索提取网页核心内容,可以关注python教程分享版块-猴子科技屋() 查看全部

网页qq抓取什么原理(如何解决一个的网页核心内容?(最优)总结(二))

目录选择的最佳总结

正文|李小飞

来源:python技术《id:pythonall》

每个人都必须熟悉爬虫程序。随便写一个获取网页信息,甚至可以根据请求自动生成python脚本[1]。

最近在网上遇到一个爬虫项目,需要爬取文章。感觉没什么特别的,但是问题是没有抓取范围的限制,也就是说没有清晰的页面结构。

对于一个页面来说,除了核心的文章内容,还有head、tail、左右列表列等等。有的页框使用div布局,有的使用table。即使两者都使用div,less网站的样式和布局是不同的。

但问题必须解决。我想,既然搜索引擎抓取了各种网页的核心内容,我们应该也能做到。拿起蟒蛇做吧!

各种尝试

如何解决?

生成pdf

开始想到一个比较棘手的方法,就是使用工具(wkhtmltopdf[2])生成目标网页的pdf文件。

好处是不需要关心页面的具体形式,就像给页面拍照一样,文章结构完整。

虽然可以在源码级别检索pdf,但是生成pdf有很多缺点:

计算资源消耗大,效率低,错误率高,体积过大。

几万条数据已经两百多g了,如果数据量上来存储,那就是大问题了。

提取 文章 内容

在不生成pdf的情况下,有一种简单的方法可以通过xpath[3]提取页面上的所有文本。

但是内容会失去结构,可读性会很差。更糟糕的是,网页上还有很多不相关的内容,比如侧边栏、广告、相关链接等,也会被提取出来,影响内容的准确性。

为了保证一定的结构和识别核心内容,只能识别和提取文章部分的结构。像搜索引擎一样学习,就是想办法识别页面的核心内容。

我们知道,一般情况下,页面的核心内容(比如文章部分)文字比较集中,可以从这个地方开始分析。

所以我写了一段代码。我使用scrapy[4] 作为爬虫框架。这里只截取了提取文章部分的代码:

divs = response.xpath("body//div") sel = none maxvalue = 0 for d in divs: ds = len(d.xpath(".//div")) ps = len(d.xpath(".//p")) value = ps - ds if value > maxvalue: sel = { "node": d, "value": value } maxvalue = value print("".join(sel['node'].getall()))

简单明了,测试几页真的很好。

但是,在提取大量页面时,发现很多页面无法提取数据。仔细一看,发现有两种情况。

再次调整策略,不再区分div,查看所有元素。

另外,更喜欢p,然后在此基础上看更少的div。调整后的代码如下:

divs = response.xpath("body//*") sels = [] maxvalue = 0 for d in divs: ds = len(d.xpath(".//div")) ps = len(d.xpath(".//p")) if ps >= maxvalue: sel = { "node": d, "ps": ps, "ds": ds } maxvalue = ps sels.append(sel) sels.sort(lambda x: x.ds) sel = sels[0] print("".join(sel['node'].getall()))

经过这次修改,确实在一定程度上弥补了之前的问题,但是引入了一个比较麻烦的问题。

发现的文章主体不稳定,特别容易受到其他部分的一些p的影响。

选最好的

由于不适合直接计算,需要重新设计算法。

发现文字集中的地方往往是文章的主体。前面的方法没有考虑这个,而是机械地找到最大的p。

还有一点,网页结构是一个dom树[6]

那么离标签p越近,就越有可能成为文章的主题,也就是说离p越近的节点权重应该越大,离p越远的节点权重就越大p 时间,但权重也应该更小。

经过反复试验,最终代码如下:

def find(node, sel): value = 0 for n in node.xpath("*"): if n.xpath("local-name()").get() == "p": t = "".join([s.strip() for s in (n.xpath('text()').getall() + n.xpath("*/text()").getall())]) value += len(t) else: value += find(n, a)*0.5 if value > sel["value"]: sel["node"] = node sel["value"] = value return value sel = { 'value': 0, 'node': none } find(response.xpath("body"), sel)

经过这次改造,效果特别好。

为什么?其实就是利用了密度原理,即离中心越近,密度越高,离中心越远,密度呈指数下降,这样就可以滤除密度中心。

50%的斜率是如何得到的?

其实是通过实验确定的。一开始,我把它设置为90%,但结果是body节点总是最好的,因为body收录了所有的文本内容。

经过反复实验,确定 50% 是一个更好的值。如果它不适合您的应用程序,您可以进行调整。

总结

在描述了我如何选择文章 主题的方法后,我没有意识到它实际上是一个非常简单的方法。而这次解题的经历,让我感受到了数学的魅力。

我一直认为,只要理解了常规的处理问题的方式,处理日常编程就足够了。当遇到不确定的问题,又没有办法提取出简单的问题模型时,常规思维显然是不行的。

因此,我们通常应该看看一些数学上很强的方法来解决不确定的问题,以提高我们的编程适应性,扩大我们的技能范围。

我希望这篇短文能对你有所启发。欢迎在留言区交流讨论,大展身手!

参考

[1]

卷曲到蟒蛇:

[2]

wkhtmltopdf:

[3]

路径:

[4]

刮擦:

[5]

查询:

[6]

dom 树:%20tree/6067246

以上就是python实现精准搜索和提取网页核心内容的详细过程。关于python搜索和提取网页内容的更多信息,请关注其他相关文章!

如果需要了解更多python教程,分享python实现精准搜索提取网页核心内容,可以关注python教程分享版块-猴子科技屋()

网页qq抓取什么原理(海豚全网搜索引擎技术框架爬虫系统的开发流程及项目展示 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 118 次浏览 • 2021-11-01 11:08

)

前言

下面文章是对搜索引擎的一般介绍,搜索引擎的开发过程请移步这里:搜索引擎开发过程

项目展示:海豚全网搜索引擎

一、爬虫系统的诞生

一般搜索引擎的处理对象是互联网网页。目前互联网网页的数量已达到数百亿。因此,搜索引擎面临的第一个问题就是如何设计一个高效的下载系统,将如此大量的网页数据传输到本地。在本地形成互联网网页的镜像备份。

网络爬虫能起到这样的作用,完成这个艰巨的任务,是搜索引擎系统中非常关键、非常基础的一个组件。

本文主要介绍与网络爬虫相关的技术。虽然爬虫经过几十年的发展,整体框架已经比较成熟,但是随着互联网的不断发展,它们也面临着一些新的挑战。

二、通用爬虫技术框架

爬虫系统首先从互联网页面中仔细选择一部分网页,将这些网页的链接地址作为种子URL,将这些种子放入URL队列中进行爬取。爬虫依次从待爬取的URL队列中读取,通过DNS Resolve传递URL,将链接地址转换为网站服务器对应的IP地址。

然后把它和网页的相对路径名交给网页下载器,网页下载器负责页面的下载。

对于本地下载的网页,一方面将其存储在页面库中,等待索引等后续处理;另一方面,将下载网页的URL放入抓取队列,记录爬虫系统已下载。网页网址,避免系统重复抓取。

对于新下载的网页,提取其中收录的所有链接信息,并在下载的URL队列中查看。如果发现该链接没有被抓取,则将其放在待抓取的URL队列的末尾。该网址对应的网页会在后续的爬取时间表中下载。

这样就形成了一个循环,直到待爬取的URL队列为空,表示爬虫系统能够爬取的所有网页都已经爬取完毕,一个完整的爬取过程到此结束。时间。

通用爬虫架构

以上就是一个通用爬虫的整体流程。如果从更宏观的角度考虑,动态抓取过程中的爬虫与互联网上所有网页的关系可以概括为以下五个部分:

已下载网页组合:爬虫已从互联网下载到本地索引的网页集合。

过期网页组合:由于网页数量较多,爬虫需要很长时间才能完成一次完整的爬取。在爬取过程中,很多下载的网页可能已经更新,导致过期。这是因为互联网网页处于不断动态变化的过程中,所以很容易产生本地网页内容与真实互联网的不一致。

待下载网页集合:URL队列中待抓取的网页,这些网页即将被爬虫下载。

已知网页集合:这些网页没有被爬虫下载,也没有出现在待抓取的URL队列中。通过已经爬取过的网页或者待爬取的URL队列中的网页,总能通过链接关系找到。稍后它将被爬虫抓取和索引。

未知网页集合:部分网页无法被爬虫抓取,这部分网页构成了未知网页的组合。事实上,这部分网页所占的比例很高。

网页划分

从理解爬虫的角度,以上对网页的划分有助于理解搜索引擎爬虫所面临的主要任务和挑战。大多数爬虫系统都遵循上述流程,但并非所有爬虫系统都如此一致。根据不同的具体应用,爬虫系统在很多方面都有所不同。一般来说,爬虫系统可以分为以下三种类型:

1. 批量爬虫:批量爬虫有比较明确的爬取范围和目标。当爬虫到达设定的目标时,它停止爬虫过程。

至于具体的目标,可能不一样,可能是设置抓取一定数量的网页,也可能是设置抓取时间等等,都是不同的。

2.增量爬虫:增量爬虫与批量爬虫不同,它会保持持续的爬行,爬取的网页必须定期更新。

由于互联网网页在不断变化,新的网页、被删除的网页或网页内容的变化是很常见的。增量爬虫需要及时反映这种变化,所以它们处于不断爬行的过程中,而不是爬行新的。该网页正在更新现有网页。常见的商业搜索引擎爬虫基本都属于这一类。

3.垂直爬虫:垂直爬虫专注于特定主题内容或属于特定行业的网页。例如,对于健康网站,您只需要从互联网页面中查找与健康相关的页面内容。不考虑其他行业的内容。

垂直爬虫最大的特点和难点之一是如何识别网页内容是否属于指定的行业或主题。

从节省系统资源的角度考虑,下载后无法过滤所有网页,会造成资源的过度浪费。爬虫往往需要在爬取阶段动态识别某个网址是否与主题相关,尽量不去爬取不相关的页面,以达到节约资源的目的。垂直搜索网站或者垂直行业网站往往需要这种类型的爬虫。

三、优秀爬虫的特点

优秀爬虫的特点针对不同的应用是不同的,但实用的爬虫应该具备以下特点:

1.高性能

互联网上的网页数量庞大,因此爬虫的性能非常重要。这里的性能主要是指爬虫下载网页的爬行速度。一种常见的评估方法是以爬虫每秒可以下载的网页数量作为性能指标。单位时间内可以下载的网页越多,爬虫的性能就越高。

为了提高爬虫的性能,程序访问磁盘的操作方法和具体实现时数据结构的选择是很关键的。比如对于要爬取的URL队列和已经爬取的URL队列,由于URL的数量非常多,不同实现方式的性能差异很大,所以高效的数据结构对爬虫的影响很大表现。

2.可扩展性

即使单个爬虫的性能非常高,下载所有网页到本地仍然需要很长时间。为了尽可能缩短爬虫周期,爬虫系统应该具有良好的可扩展性,即很容易增加Grab的服务器和爬虫数量来达到这个目的。

当前可用的大型网络爬虫必须是分布式的,即多个服务器专用于爬虫。每个服务器部署多个爬虫,每个爬虫运行在多个线程中,以多种方式增加并发。

对于大型搜索引擎服务商来说,可能需要在全球、不同地区部署数据中心,并且爬虫也被分配到不同的数据中心,这对于提升爬虫系统的整体性能非常有帮助。

3. 鲁棒性

爬虫想要访问各种类型的网站服务器,可能会遇到很多异常情况:比如网页HTML编码不规范,被爬取的服务器突然崩溃,甚至爬虫陷阱。爬虫能够正确处理各种异常情况非常重要,否则可能会时不时停止工作,难以忍受。

从另一个角度来看,假设爬虫程序在爬取过程中死亡,或者爬虫所在的服务器宕机,一个健壮的爬虫应该能够做到:当爬虫再次启动时,它可以恢复内容和数据结构以前爬过。不用每次都从头开始做所有的工作,这也是爬虫健壮性的体现。

4.友善

爬虫的友善有两层意思:一是保护网站的部分隐私;另一个是减少网站被爬取的网络负载。爬虫爬取的对象是各种类型的网站。对于网站的拥有者来说,有些内容不想被大家搜索到,所以需要设置一个协议来通知爬虫哪些内容是不允许爬取的。目前实现这一目标的主流方法有两种:爬虫禁止协议和网页禁止标记。

禁止爬取协议是指网站的所有者生成的一个指定文件robot.txt,放置在网站服务器的根目录下。该文件指定了网站中哪些目录不允许爬虫爬取以下网页。一个友好的爬虫在爬取网站网页之前必须先读取robot.txt文件,不会下载禁止爬取的网页。

网页禁止标记一般会在网页的HTML代码中添加meta name="robots"标记,内容字段表示允许或不允许爬虫的哪些行为。可以分为两种情况:一种是告诉爬虫不要索引网页内容,以noindex为标志;另一种是告诉爬虫不要爬取网页中收录的链接,以nofollow为标志。通过这种方式,可以实现对网页内容的一种隐私保护。

遵循上述协议的爬虫可以认为是友好的,这是从保护隐私的角度考虑的;另一种友善是希望爬虫对某个网站的访问会造成较低的网络负载。.

爬虫一般会根据网页的链接不断获取某个网站网页。如果爬虫频繁访问网站,会对网站服务器造成很大的访问压力,有时甚至会影响到它。网站的正常访问,产生类似DOS攻击的效果。

为了降低网站的网络负载,友好的爬虫在部署爬取策略时应该考虑每次爬取到的网站的负载,减少短时间内对站点的单次高频访问次数时间。

四、 爬虫质量评价标准

从搜索引擎用户体验的角度来看,爬虫的有效性有不同的评价标准。三个主要标准是:被抓取网页的覆盖率、抓取网页的新颖性和抓取网页的重要性。如果这三个方面做得好,搜索引擎的用户体验一定是好的。

对于现有的搜索引擎来说,没有一个搜索引擎能够下载并索引出现在互联网上的所有网页,所有的搜索引擎只能索引互联网的一部分。所谓爬取覆盖率是指爬虫所爬取的网页数量占互联网上所有网页数量的比例。覆盖率越高,搜索引擎召回率越高,用户体验越好。

索引页和互联网页的比较

抓取到的本地网页很可能发生了变化,或者被删除,或者内容发生了变化。因为爬虫需要很长时间才能完成一轮爬取,所以爬取到的部分网页肯定是过时的。网页改变后,数据无法立即反映到网页库中。因此,网页库中的过期数据越少,网页的当前性越好,对用户体验的提升大有裨益。

如果当前性不好,搜索到的数据全部过时,或者网页被删除,用户的内心感受可想而知。

虽然互联网上有很多网页,但每个网页都大不相同。例如,腾讯和网易新闻的网页与作弊网页一样重要。如果搜索引擎抓取的大部分网页都是比较重要的网页,说明他们在抓取网页的重要性方面做得不错。在这方面做得越好,搜索引擎的搜索准确性就越高。

通过以上三个标准的解释和分析,爬虫研发的目标可以简单描述如下: 在资源有限的情况下,由于搜索引擎只能抓取互联网上现有网页的一部分,那么尽量选择更重要的部分进行页面索引;对已爬取的网页,尽快更新内容,使收录的网页内容与互联网上对应的页面同步更新;在此基础上,尽可能扩大抓取范围,抓取更多之前找不到的页面。

三个“尽可能”基本明确了爬虫系统提升用户体验的目标。

为了满足这三个质量标准,大多数大型商业搜索引擎都开发了一些针对性很强的爬虫系统。以谷歌为例,它至少收录两种不同的爬虫系统:一种叫做Fresh Bot,主要考虑网页的新鲜度。对于内容更新频繁的网页,可以达到当前秒更新周期;另一套被称为Deep Crawl Bot,主要用于抓取更新不那么频繁的网页,更新周期为天。

此外,谷歌还投入了大量精力开发暗网抓取系统。后续有时间我们会讲解暗网系统。

谷歌的两个爬虫系统

五、最终总结

阅读本文,通过了解爬虫的技术架构、爬虫的种类、优秀爬虫的特点、爬虫质量标准,相信你对爬虫系统有了初步系统的了解,最后对主要知识点做一个简单的程序化视图总结:

爬虫爬取网页工作流程:选择要爬取的网页,依次放入爬取队列;系统将网页的链接地址依次转换为IP地址,下载到本地后进行存储和标记,避免重复下载;继续执行新一轮的爬行,一次又一次地重复。

爬虫与互联网上所有网页的关系:结合已下载页面、结合过期页面、结合待下载页面、结合已知页面、结合未知页面

爬虫类型:批量爬虫、增量爬虫、垂直爬虫

优秀爬虫的特点:高性能、可扩展性、健壮性、友好性

爬虫质量评价标准:被抓取网页的覆盖范围、抓取网页的新鲜度、抓取网页的重要性

我的搜索引擎项目地址:海豚搜索

如果你也对搜索引擎感兴趣,可以一起交流

查看全部

网页qq抓取什么原理(海豚全网搜索引擎技术框架爬虫系统的开发流程及项目展示

)

前言

下面文章是对搜索引擎的一般介绍,搜索引擎的开发过程请移步这里:搜索引擎开发过程

项目展示:海豚全网搜索引擎

一、爬虫系统的诞生

一般搜索引擎的处理对象是互联网网页。目前互联网网页的数量已达到数百亿。因此,搜索引擎面临的第一个问题就是如何设计一个高效的下载系统,将如此大量的网页数据传输到本地。在本地形成互联网网页的镜像备份。

网络爬虫能起到这样的作用,完成这个艰巨的任务,是搜索引擎系统中非常关键、非常基础的一个组件。

本文主要介绍与网络爬虫相关的技术。虽然爬虫经过几十年的发展,整体框架已经比较成熟,但是随着互联网的不断发展,它们也面临着一些新的挑战。

二、通用爬虫技术框架

爬虫系统首先从互联网页面中仔细选择一部分网页,将这些网页的链接地址作为种子URL,将这些种子放入URL队列中进行爬取。爬虫依次从待爬取的URL队列中读取,通过DNS Resolve传递URL,将链接地址转换为网站服务器对应的IP地址。

然后把它和网页的相对路径名交给网页下载器,网页下载器负责页面的下载。

对于本地下载的网页,一方面将其存储在页面库中,等待索引等后续处理;另一方面,将下载网页的URL放入抓取队列,记录爬虫系统已下载。网页网址,避免系统重复抓取。

对于新下载的网页,提取其中收录的所有链接信息,并在下载的URL队列中查看。如果发现该链接没有被抓取,则将其放在待抓取的URL队列的末尾。该网址对应的网页会在后续的爬取时间表中下载。

这样就形成了一个循环,直到待爬取的URL队列为空,表示爬虫系统能够爬取的所有网页都已经爬取完毕,一个完整的爬取过程到此结束。时间。

通用爬虫架构

以上就是一个通用爬虫的整体流程。如果从更宏观的角度考虑,动态抓取过程中的爬虫与互联网上所有网页的关系可以概括为以下五个部分:

已下载网页组合:爬虫已从互联网下载到本地索引的网页集合。

过期网页组合:由于网页数量较多,爬虫需要很长时间才能完成一次完整的爬取。在爬取过程中,很多下载的网页可能已经更新,导致过期。这是因为互联网网页处于不断动态变化的过程中,所以很容易产生本地网页内容与真实互联网的不一致。

待下载网页集合:URL队列中待抓取的网页,这些网页即将被爬虫下载。

已知网页集合:这些网页没有被爬虫下载,也没有出现在待抓取的URL队列中。通过已经爬取过的网页或者待爬取的URL队列中的网页,总能通过链接关系找到。稍后它将被爬虫抓取和索引。

未知网页集合:部分网页无法被爬虫抓取,这部分网页构成了未知网页的组合。事实上,这部分网页所占的比例很高。

网页划分

从理解爬虫的角度,以上对网页的划分有助于理解搜索引擎爬虫所面临的主要任务和挑战。大多数爬虫系统都遵循上述流程,但并非所有爬虫系统都如此一致。根据不同的具体应用,爬虫系统在很多方面都有所不同。一般来说,爬虫系统可以分为以下三种类型:

1. 批量爬虫:批量爬虫有比较明确的爬取范围和目标。当爬虫到达设定的目标时,它停止爬虫过程。

至于具体的目标,可能不一样,可能是设置抓取一定数量的网页,也可能是设置抓取时间等等,都是不同的。

2.增量爬虫:增量爬虫与批量爬虫不同,它会保持持续的爬行,爬取的网页必须定期更新。

由于互联网网页在不断变化,新的网页、被删除的网页或网页内容的变化是很常见的。增量爬虫需要及时反映这种变化,所以它们处于不断爬行的过程中,而不是爬行新的。该网页正在更新现有网页。常见的商业搜索引擎爬虫基本都属于这一类。

3.垂直爬虫:垂直爬虫专注于特定主题内容或属于特定行业的网页。例如,对于健康网站,您只需要从互联网页面中查找与健康相关的页面内容。不考虑其他行业的内容。

垂直爬虫最大的特点和难点之一是如何识别网页内容是否属于指定的行业或主题。

从节省系统资源的角度考虑,下载后无法过滤所有网页,会造成资源的过度浪费。爬虫往往需要在爬取阶段动态识别某个网址是否与主题相关,尽量不去爬取不相关的页面,以达到节约资源的目的。垂直搜索网站或者垂直行业网站往往需要这种类型的爬虫。

三、优秀爬虫的特点

优秀爬虫的特点针对不同的应用是不同的,但实用的爬虫应该具备以下特点:

1.高性能

互联网上的网页数量庞大,因此爬虫的性能非常重要。这里的性能主要是指爬虫下载网页的爬行速度。一种常见的评估方法是以爬虫每秒可以下载的网页数量作为性能指标。单位时间内可以下载的网页越多,爬虫的性能就越高。

为了提高爬虫的性能,程序访问磁盘的操作方法和具体实现时数据结构的选择是很关键的。比如对于要爬取的URL队列和已经爬取的URL队列,由于URL的数量非常多,不同实现方式的性能差异很大,所以高效的数据结构对爬虫的影响很大表现。

2.可扩展性

即使单个爬虫的性能非常高,下载所有网页到本地仍然需要很长时间。为了尽可能缩短爬虫周期,爬虫系统应该具有良好的可扩展性,即很容易增加Grab的服务器和爬虫数量来达到这个目的。

当前可用的大型网络爬虫必须是分布式的,即多个服务器专用于爬虫。每个服务器部署多个爬虫,每个爬虫运行在多个线程中,以多种方式增加并发。

对于大型搜索引擎服务商来说,可能需要在全球、不同地区部署数据中心,并且爬虫也被分配到不同的数据中心,这对于提升爬虫系统的整体性能非常有帮助。

3. 鲁棒性

爬虫想要访问各种类型的网站服务器,可能会遇到很多异常情况:比如网页HTML编码不规范,被爬取的服务器突然崩溃,甚至爬虫陷阱。爬虫能够正确处理各种异常情况非常重要,否则可能会时不时停止工作,难以忍受。

从另一个角度来看,假设爬虫程序在爬取过程中死亡,或者爬虫所在的服务器宕机,一个健壮的爬虫应该能够做到:当爬虫再次启动时,它可以恢复内容和数据结构以前爬过。不用每次都从头开始做所有的工作,这也是爬虫健壮性的体现。

4.友善

爬虫的友善有两层意思:一是保护网站的部分隐私;另一个是减少网站被爬取的网络负载。爬虫爬取的对象是各种类型的网站。对于网站的拥有者来说,有些内容不想被大家搜索到,所以需要设置一个协议来通知爬虫哪些内容是不允许爬取的。目前实现这一目标的主流方法有两种:爬虫禁止协议和网页禁止标记。

禁止爬取协议是指网站的所有者生成的一个指定文件robot.txt,放置在网站服务器的根目录下。该文件指定了网站中哪些目录不允许爬虫爬取以下网页。一个友好的爬虫在爬取网站网页之前必须先读取robot.txt文件,不会下载禁止爬取的网页。

网页禁止标记一般会在网页的HTML代码中添加meta name="robots"标记,内容字段表示允许或不允许爬虫的哪些行为。可以分为两种情况:一种是告诉爬虫不要索引网页内容,以noindex为标志;另一种是告诉爬虫不要爬取网页中收录的链接,以nofollow为标志。通过这种方式,可以实现对网页内容的一种隐私保护。

遵循上述协议的爬虫可以认为是友好的,这是从保护隐私的角度考虑的;另一种友善是希望爬虫对某个网站的访问会造成较低的网络负载。.

爬虫一般会根据网页的链接不断获取某个网站网页。如果爬虫频繁访问网站,会对网站服务器造成很大的访问压力,有时甚至会影响到它。网站的正常访问,产生类似DOS攻击的效果。

为了降低网站的网络负载,友好的爬虫在部署爬取策略时应该考虑每次爬取到的网站的负载,减少短时间内对站点的单次高频访问次数时间。

四、 爬虫质量评价标准

从搜索引擎用户体验的角度来看,爬虫的有效性有不同的评价标准。三个主要标准是:被抓取网页的覆盖率、抓取网页的新颖性和抓取网页的重要性。如果这三个方面做得好,搜索引擎的用户体验一定是好的。

对于现有的搜索引擎来说,没有一个搜索引擎能够下载并索引出现在互联网上的所有网页,所有的搜索引擎只能索引互联网的一部分。所谓爬取覆盖率是指爬虫所爬取的网页数量占互联网上所有网页数量的比例。覆盖率越高,搜索引擎召回率越高,用户体验越好。

索引页和互联网页的比较

抓取到的本地网页很可能发生了变化,或者被删除,或者内容发生了变化。因为爬虫需要很长时间才能完成一轮爬取,所以爬取到的部分网页肯定是过时的。网页改变后,数据无法立即反映到网页库中。因此,网页库中的过期数据越少,网页的当前性越好,对用户体验的提升大有裨益。

如果当前性不好,搜索到的数据全部过时,或者网页被删除,用户的内心感受可想而知。

虽然互联网上有很多网页,但每个网页都大不相同。例如,腾讯和网易新闻的网页与作弊网页一样重要。如果搜索引擎抓取的大部分网页都是比较重要的网页,说明他们在抓取网页的重要性方面做得不错。在这方面做得越好,搜索引擎的搜索准确性就越高。

通过以上三个标准的解释和分析,爬虫研发的目标可以简单描述如下: 在资源有限的情况下,由于搜索引擎只能抓取互联网上现有网页的一部分,那么尽量选择更重要的部分进行页面索引;对已爬取的网页,尽快更新内容,使收录的网页内容与互联网上对应的页面同步更新;在此基础上,尽可能扩大抓取范围,抓取更多之前找不到的页面。

三个“尽可能”基本明确了爬虫系统提升用户体验的目标。

为了满足这三个质量标准,大多数大型商业搜索引擎都开发了一些针对性很强的爬虫系统。以谷歌为例,它至少收录两种不同的爬虫系统:一种叫做Fresh Bot,主要考虑网页的新鲜度。对于内容更新频繁的网页,可以达到当前秒更新周期;另一套被称为Deep Crawl Bot,主要用于抓取更新不那么频繁的网页,更新周期为天。

此外,谷歌还投入了大量精力开发暗网抓取系统。后续有时间我们会讲解暗网系统。

谷歌的两个爬虫系统

五、最终总结

阅读本文,通过了解爬虫的技术架构、爬虫的种类、优秀爬虫的特点、爬虫质量标准,相信你对爬虫系统有了初步系统的了解,最后对主要知识点做一个简单的程序化视图总结:

爬虫爬取网页工作流程:选择要爬取的网页,依次放入爬取队列;系统将网页的链接地址依次转换为IP地址,下载到本地后进行存储和标记,避免重复下载;继续执行新一轮的爬行,一次又一次地重复。

爬虫与互联网上所有网页的关系:结合已下载页面、结合过期页面、结合待下载页面、结合已知页面、结合未知页面

爬虫类型:批量爬虫、增量爬虫、垂直爬虫

优秀爬虫的特点:高性能、可扩展性、健壮性、友好性

爬虫质量评价标准:被抓取网页的覆盖范围、抓取网页的新鲜度、抓取网页的重要性

我的搜索引擎项目地址:海豚搜索

如果你也对搜索引擎感兴趣,可以一起交流

网页qq抓取什么原理(百度爬虫抓取量(CrawlerCrawlingVolumeVolume)(图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 86 次浏览 • 2021-10-31 22:11

百度爬虫爬网量(Baidu Crawler Crawling Volume)实际上是百度爬虫一天爬取的网页网站的数量。根据百度内部披露,一般有两种类型的网页需要被抓取。其中之一是网站生成新的网页,中小型网站当天即可完成。大的网站 可能无法完成网页。另一个是之前百度抓取的网页,需要更新。

1.看看你的知识产权是否有很大的网站。

百度蜘蛛一般会爬取知识产权,爬取知识产权的次数是有限的。如果你的 IP 上有很多站点,那么分配给一个站点的爬虫次数会更少,尤其是当有 IP 的大型站点时。另外,一方面,有网站的有知识产权的网站在活跃。如果它们和你的网站相似,也会从侧面影响你的网站的爬取。所以网站优化应该尽量选择自主知识产权。

2.内容质量

百度官方文档虽然没有对原文内容的词汇,但其实百度想要表达的内容,只要对客户有用就行。虽然不是原创,但也会给个不错的排名。因此,有很多方法可以为非原创内容生成内容。百度争夺排名的最佳方式是添加内容子模块的随机组合。结果很好,参赛作品也很好。不过大部分站长都明白,非原创的作品都是转载抄袭,比如伪原创等,百度蜘蛛对这些网站的心情可想而知。

退一步说,如果你真的想成为一个伪原创,你必须确保至少有30%的差异可以组合处理。

网站保证内容质量的另一个方面是限制百度访问某些类型的网站。百度在输入你的网站之前会对你的网站进行评分,并根据评分来决定你会输入多少你的网站。这也是很多站长长期放弃投稿的根本原因。

为此,我们需要在有用项目的数量上取得进展。百度排名的根本原因是提供高质量的内容页面来掩盖搜索需求。遗憾的是,百度对优质内容页面的排名通常是原创,所以想通过伪原创查找文章内容的站长可以保存。

3.场地刚性

网站管理员有时间注意你的网站严格。比如你的网站打不开,跳到黑链,被WEBSHELL抓到,网站管理员就得在百度网站 管理员工具救援。一般来说,网站 被黑链黑了,所以我们有时间看看是否有很多黑链添加到我们的源代码中。黑链是分批添加的,视觉上很容易区分。如果您不能及时处理,百度爬虫可能会抓取相关页面并跳转到非法页面,从而降低您的功耗。百度要挂黑链降级,实属不易。

4.网站的打开速度和加载速度

网站的打开速度会影响百度蜘蛛从侧面爬行。虽然蜘蛛抓取你的网页并没有太大区别(其实网页越大,百度展示的网页就越丰富),但从用户的角度来看,当你的网页被打开和加载时3秒当搜索引擎优化网站营销类型会增加跳转率时,跳转率高会影响你的网站评分,较低的网站评分会导致较低的网站 条目。因此,百度排名的打开速度将直接影响百度蜘蛛的抓取。 查看全部

网页qq抓取什么原理(百度爬虫抓取量(CrawlerCrawlingVolumeVolume)(图))

百度爬虫爬网量(Baidu Crawler Crawling Volume)实际上是百度爬虫一天爬取的网页网站的数量。根据百度内部披露,一般有两种类型的网页需要被抓取。其中之一是网站生成新的网页,中小型网站当天即可完成。大的网站 可能无法完成网页。另一个是之前百度抓取的网页,需要更新。

1.看看你的知识产权是否有很大的网站。

百度蜘蛛一般会爬取知识产权,爬取知识产权的次数是有限的。如果你的 IP 上有很多站点,那么分配给一个站点的爬虫次数会更少,尤其是当有 IP 的大型站点时。另外,一方面,有网站的有知识产权的网站在活跃。如果它们和你的网站相似,也会从侧面影响你的网站的爬取。所以网站优化应该尽量选择自主知识产权。

2.内容质量

百度官方文档虽然没有对原文内容的词汇,但其实百度想要表达的内容,只要对客户有用就行。虽然不是原创,但也会给个不错的排名。因此,有很多方法可以为非原创内容生成内容。百度争夺排名的最佳方式是添加内容子模块的随机组合。结果很好,参赛作品也很好。不过大部分站长都明白,非原创的作品都是转载抄袭,比如伪原创等,百度蜘蛛对这些网站的心情可想而知。

退一步说,如果你真的想成为一个伪原创,你必须确保至少有30%的差异可以组合处理。

网站保证内容质量的另一个方面是限制百度访问某些类型的网站。百度在输入你的网站之前会对你的网站进行评分,并根据评分来决定你会输入多少你的网站。这也是很多站长长期放弃投稿的根本原因。

为此,我们需要在有用项目的数量上取得进展。百度排名的根本原因是提供高质量的内容页面来掩盖搜索需求。遗憾的是,百度对优质内容页面的排名通常是原创,所以想通过伪原创查找文章内容的站长可以保存。

3.场地刚性

网站管理员有时间注意你的网站严格。比如你的网站打不开,跳到黑链,被WEBSHELL抓到,网站管理员就得在百度网站 管理员工具救援。一般来说,网站 被黑链黑了,所以我们有时间看看是否有很多黑链添加到我们的源代码中。黑链是分批添加的,视觉上很容易区分。如果您不能及时处理,百度爬虫可能会抓取相关页面并跳转到非法页面,从而降低您的功耗。百度要挂黑链降级,实属不易。

4.网站的打开速度和加载速度

网站的打开速度会影响百度蜘蛛从侧面爬行。虽然蜘蛛抓取你的网页并没有太大区别(其实网页越大,百度展示的网页就越丰富),但从用户的角度来看,当你的网页被打开和加载时3秒当搜索引擎优化网站营销类型会增加跳转率时,跳转率高会影响你的网站评分,较低的网站评分会导致较低的网站 条目。因此,百度排名的打开速度将直接影响百度蜘蛛的抓取。

网页qq抓取什么原理(移动开发中的打电话框架如何实现自动弹(图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 83 次浏览 • 2021-10-31 22:11

我仔细研究了这些网站的源码,发现了一件事。一般目前网站很少使用framework,因为搜索引擎无法识别framework,但是这些网站有一个Frame,frame的地址是简单的一行地址,并不是http的地址,例如如下地址:

腾讯://message/?uin=1278230143&Site=&menu=yes

这有点像移动开发中的调用链接,应该是调用自己电脑的软件。

自动弹出QQ对话框的方法可以实现大量的客户查询。相比“左一右一再中一”客服组件,可以通过“打开网页,自动弹出QQ对话框”来实现。提高咨询量在用户体验和有效性方面要强得多。

每个浏览器可能会略微不同地实现此代码。Firefox 会让你选择打开这个链接的应用程序,用户也可以勾选“记住我选择的腾讯类型链接。(R)”,这样以后就不会弹出选择应用程序的对话框了。

IE等浏览器会直接弹出对话框,但是如果你同时登录多个QQ,那么他会让你选择一个QQ聊天。

这段代码是放置的,但是需要用户点击。这不是我们需要的效果。我们希望用户打开网页时弹出这个对话框,那么如何实现

自动弹出对话框

我们在网页上放置一个框架,框架的地址就是上面的代码。网页加载时会自动访问这个地址,所以会自动弹出QQ聊天窗口。当然,我们需要将这个框架设置为不显示。用户无法看到。

设置多个客服QQ

针对企业存在多个客服的情况,直接合理分配接待客服。我刚想出一个办法,就是预设多个客服QQ,然后随机弹出一个客服QQ对话框给访问者!当然,这适用于企业,但对于个人站长来说不是必需的。

延迟弹出对话框

很多客户问我如何设置页面在访问者打开后10秒后弹出。我再次研究并更新了这个弹出窗口。我确实找到了一种方法来设置它在 10 秒后弹出!这样可以在一定程度上提升用户体验,同时让访问者首先看到网站的优质服务可以有效提升客户对产品的认可度,从而增加客户对产品的认知度。积极沟通!

好了,以上就是三种设置方法,一种比另一种高级,希望对你有帮助。 查看全部

网页qq抓取什么原理(移动开发中的打电话框架如何实现自动弹(图))

我仔细研究了这些网站的源码,发现了一件事。一般目前网站很少使用framework,因为搜索引擎无法识别framework,但是这些网站有一个Frame,frame的地址是简单的一行地址,并不是http的地址,例如如下地址:

腾讯://message/?uin=1278230143&Site=&menu=yes

这有点像移动开发中的调用链接,应该是调用自己电脑的软件。

自动弹出QQ对话框的方法可以实现大量的客户查询。相比“左一右一再中一”客服组件,可以通过“打开网页,自动弹出QQ对话框”来实现。提高咨询量在用户体验和有效性方面要强得多。

每个浏览器可能会略微不同地实现此代码。Firefox 会让你选择打开这个链接的应用程序,用户也可以勾选“记住我选择的腾讯类型链接。(R)”,这样以后就不会弹出选择应用程序的对话框了。

IE等浏览器会直接弹出对话框,但是如果你同时登录多个QQ,那么他会让你选择一个QQ聊天。

这段代码是放置的,但是需要用户点击。这不是我们需要的效果。我们希望用户打开网页时弹出这个对话框,那么如何实现

自动弹出对话框

我们在网页上放置一个框架,框架的地址就是上面的代码。网页加载时会自动访问这个地址,所以会自动弹出QQ聊天窗口。当然,我们需要将这个框架设置为不显示。用户无法看到。

设置多个客服QQ

针对企业存在多个客服的情况,直接合理分配接待客服。我刚想出一个办法,就是预设多个客服QQ,然后随机弹出一个客服QQ对话框给访问者!当然,这适用于企业,但对于个人站长来说不是必需的。

延迟弹出对话框

很多客户问我如何设置页面在访问者打开后10秒后弹出。我再次研究并更新了这个弹出窗口。我确实找到了一种方法来设置它在 10 秒后弹出!这样可以在一定程度上提升用户体验,同时让访问者首先看到网站的优质服务可以有效提升客户对产品的认可度,从而增加客户对产品的认知度。积极沟通!

好了,以上就是三种设置方法,一种比另一种高级,希望对你有帮助。

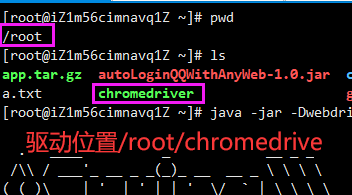

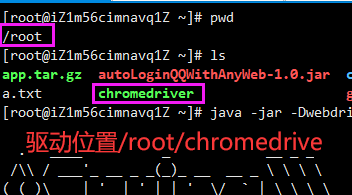

网页qq抓取什么原理(Java+selenium-java实现qq自动登录并获取cookie路径 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 134 次浏览 • 2021-10-31 13:14

)

开源地址:

注意:如果下载了源码,想在自己的windows环境下测试,把源码添加到top.yumbo.music.test.configuration.ChromeAutoConfigration

打开指定chromedriver路径的注释,指向正确的chromedriver路径,(chromedriver是驱动,电脑上也需要chrome浏览器)

// 打开注释并且将值设置为正确的路径

System.setProperty("webdriver.chrome.driver", "D:/Program Files (x86)/chromedriver/chromedriver.exe");

Windows和Linux类似,只要环境设置好,然后就可以快速执行程序登录

全局参数说明

项目中暴露了两种类型的接口:(可以使用post/get,也支持json字符串请求)

返回数据的格式:如果没有填写format,则默认返回Cookie对象

一种是已经写好的登录,比如qq音乐,网易云音乐,csdn网站可以直接在请求路径中处理

一种是通过传入登录页面的URL来登录

如何使用第一类接口:

请求路径:/login/qq/{name} 在枚举对象WebLoginEnum中定义name,两个参数的构造方法,第一个参数是name,第二个参数是登录页面的url

QQ音乐登录在线地址格式:

:7000/login/qq/music?username=number&password=password&format=2

网易云音乐登录在线地址格式:

:7000/login/qq/netease?username=number&password=password&format=2

csdn

QQ音乐登录在线地址格式(post/get都可以,也支持json字符串):

:7000/login/qq/csdn?username=number&password=password&format=2

如何使用第二个界面

请求路径:/login/qq

在线地址格式:

注意:注意url编码问题,传入的url可以直接从浏览器地址栏复制过来,如果是自己抓取解析的,注意编码

http://yumbo.top:7000/login/qq?username=qq号&password=qq密码&format=2&url=登录页面的url

如果想看效果,看这篇博客,有gif演示效果:

java+selenium-java实现QQ自动登录并获取cookies

完整的环境搭建流程

如果github不能显示图片,去csdn看我的博客:实现网站的所有QQ登录都返回登录后的cookie信息

原理与实现 第一步在Linux服务器上安装google-chrome(谷歌浏览器)

Centos操作系统的使用如下

下载rpm包

wget https://dl.google.com/linux/di ... 4.rpm

安装依赖

sudo yum install -y lsb

安装

sudo yum localinstall google-chrome-stable_current_x86_64.rpm

对于 Ubuntu 用户,请使用以下命令

以下命令不建议以root身份下载

因为可能会报告权限问题:

N: 下载是作为 root 作为文件'/root/google-chrome-stable_current_amd64.deb' 无法被用户'_apt'访问执行的。-pkgAcquire::Run (13: Permission denied)

下载 deb 包

wget https://dl.google.com/linux/di ... 4.deb

安装 deb 包

sudo apt install -y ./google-chrome-stable_current_amd64.deb

完成后,Centos 和 Ubuntu 将多了一个命令

google-chrome

第二步是下载chromedriver。它的功能是操作google-chrome浏览器,也就是通过它来操作谷歌浏览器

下载链接:

随便选一个,我选的是这个版本:

通过FTP工具上传到linux服务器

ftp 工具如:FileZila 下载页面选择适合你的

或者 xftp

ftp工具和chromedriver也可以通过下面的csdn下载,我是打包成zip包的。您也可以通过选择之前发布的链接自行下载界面

把他上传到一个目录,比如/root

授予执行权限

执行后会出现绿色提示。

chmod 777 chromedriver

第三步,下载jar包,或者自己去github制作一个jar包

jar包下载地址:

需要先修复java环境

对于 Ubuntu: apt install -y openjdk-14-jre-headless 进行安装

Centos: yum install -y java-11-openjdk-devel.x86_64 即可安装(如需配置环境变量可自行配置)

是springboot项目,端口为:7000,可以通过运行参数-Dserver.port修改启动端口

提醒

-Dwebdriver.chrome.driver 是指定驱动器的位置,请改成正确的位置

如果是默认的根目录,可以更改对应的路径

java -jar -Dwebdriver.chrome.driver=/root/chromedriver \

-Dserver.port=7000 autoLoginQQWithAnyWeb-1.0.jar

第四步,发送获取cookie信息的请求

都支持get/post,接收json/pass参数

如下

接口地址:7000/login/{name}

QQ音乐在线地址:7000/登录/音乐

网易云音乐在线地址:7000/登录/网易

csdn在线地址:7000/login/csdn

以下是qq音乐的登录地址(qq音乐不会跳转到后台界面,需要通过抓包来分析)

替换下面的用户名和密码完成登录QQ音乐后获取cookie

复制方便:以下模板只适用于qq音乐,其他网站可以直接复制url代替这个参数的url,根据页面补充如下参数

http://yumbo.top:7000/login/qq/music?username=qq号&password=qq密码&format=2

参数补充说明

以CSDN的登录页面为例,请求地址如下

上面地址之后会跳转到下面的页面(上面的地址会自动跳转到请求授权的页面)

这里有一个过程。该地址的服务器会自动向腾讯的oauth2.0服务器发送请求,然后返回这个统一授权页面。因为这个页面是统一的,所以写了脚本。它会自动点击账号和密码登录===>输入账号和密码==>QQ登录成功后会自动跳转到回调地址,然后在登录后获取cookie成功的

然后我抓住了机会。一般来说,如果我通过上述方式获取url,应该不是拖放验证的步骤。

枚举网站的登录页面地址,然后访问地址,输入用户名和密码登录,登录成功后会自动跳转到登录页面,刷新一次页面,然后得到cookie,并将cookie传输到json Object return {"cookie":"cookie string or native array"}

处理请求的控制器源代码

<p>package top.yumbo.music.test.controller;

import com.alibaba.fastjson.JSONObject;

import org.openqa.selenium.By;

import org.openqa.selenium.Cookie;

import org.openqa.selenium.WebDriver;

import org.openqa.selenium.WebElement;

import org.openqa.selenium.chrome.ChromeDriver;

import org.springframework.util.StringUtils;

import org.springframework.web.bind.annotation.*;

import top.yumbo.music.test.web.WebLoginEnum;

import javax.annotation.Resource;

import java.util.Set;

@RestController

public class LoginController {

@Resource

ChromeDriver chromeDriver;

@Resource

WebDriver.Options manage;

/**

* cookie数据的处理

*

* @param cookies 传入cookie的集合

* @return k1=v1;k2=v2; 这种形式的cookie字符串

*/

private String parseCookieSet(Set cookies) {

if (cookies == null) {

return "";

}

System.out.println("\n解析前cookie是" + cookies.toString());

String cookieString = "";

for (Cookie cookie : cookies) {

if (StringUtils.hasText(cookie.getValue())) {// 为空的cookie则去除

cookieString += (cookie.getName() + "=" + cookie.getValue() + ";");

}

}

System.out.println("解析后:\n" + cookieString);

return cookieString;

}

@GetMapping({"/login/qq/{name}"})

public JSONObject commonLogin(@RequestBody(required = false) JSONObject jsonObject,

@PathVariable(value = "name") String name,

@RequestParam(value = "username", required = false) String username,

@RequestParam(value = "password") String password,

@RequestParam(value = "format", required = false, defaultValue = "1") String format) {

if (StringUtils.hasText(username) && StringUtils.hasText(password)) {

// 什么也不做

} else if (jsonObject != null

&& StringUtils.hasText(jsonObject.getString("username"))

&& StringUtils.hasText(jsonObject.getString("password"))) {

username = jsonObject.getString("username");

password = jsonObject.getString("password");

} else {

final JSONObject error = new JSONObject();

if (jsonObject != null) {

error.put("输入了错误的信息", jsonObject);

} else {

final JSONObject info = new JSONObject();

info.put("username", username);

info.put("password", password);

error.put("输入了错误的信息", info);

}

return error;

}

return LoginAndGetCookie(username, password, name, format);

}

/**

* 登录已知类型的网站

*

* @param username qq账号

* @param password qq密码

* @param name 枚举登录页面的封装类,如果hashMap中没有则这个name就是登录页面的地址

* @param format 返回的cookie类型,1表示原cookie数据,2表示处理后的cookie

* @return json类型的cookie封装类

*/

public JSONObject LoginAndGetCookie(String username, String password, String name, String format) {

final JSONObject cookieJson = new JSONObject();

try {

// 登录前先清除cookie

final String url = WebLoginEnum.getUrl(name);

if (!StringUtils.hasText(url)) {

cookieJson.put("msg", "网站没有引入项目,请使用另外一个接口进行登录");

return cookieJson;

}

manage.deleteAllCookies();// 清除cookie

chromeDriver.get(url);// 访问登录页面

final WebDriver ptlogin_iframe = chromeDriver.switchTo().frame("ptlogin_iframe");

ptlogin_iframe.findElement(By.id("switcher_plogin")).click();

final WebElement u = ptlogin_iframe.findElement(By.className("inputstyle"));

u.clear();// 清空输入的用户名

u.sendKeys(username + "\n");// 输入账号

final WebElement p = ptlogin_iframe.findElement(By.id("p"));

p.clear();// 清空输入的密码数据

p.sendKeys(password + "\n");// 输入密码,回车就提交了下面的这个点击登录不需要

final String beforeUrl = chromeDriver.getCurrentUrl();

while (chromeDriver.getCurrentUrl().equals(beforeUrl)) {

// 页面没有跳转就让他等待,等待自己重定向到登录后的页面,然后再获取cookie时就是正确的cookie

}

System.out.println("=======等待登录成功后跳转到页面 查看全部

网页qq抓取什么原理(Java+selenium-java实现qq自动登录并获取cookie路径

)

开源地址:

注意:如果下载了源码,想在自己的windows环境下测试,把源码添加到top.yumbo.music.test.configuration.ChromeAutoConfigration

打开指定chromedriver路径的注释,指向正确的chromedriver路径,(chromedriver是驱动,电脑上也需要chrome浏览器)

// 打开注释并且将值设置为正确的路径

System.setProperty("webdriver.chrome.driver", "D:/Program Files (x86)/chromedriver/chromedriver.exe");

Windows和Linux类似,只要环境设置好,然后就可以快速执行程序登录

全局参数说明

项目中暴露了两种类型的接口:(可以使用post/get,也支持json字符串请求)

返回数据的格式:如果没有填写format,则默认返回Cookie对象

一种是已经写好的登录,比如qq音乐,网易云音乐,csdn网站可以直接在请求路径中处理

一种是通过传入登录页面的URL来登录

如何使用第一类接口:

请求路径:/login/qq/{name} 在枚举对象WebLoginEnum中定义name,两个参数的构造方法,第一个参数是name,第二个参数是登录页面的url

QQ音乐登录在线地址格式:

:7000/login/qq/music?username=number&password=password&format=2

网易云音乐登录在线地址格式:

:7000/login/qq/netease?username=number&password=password&format=2

csdn

QQ音乐登录在线地址格式(post/get都可以,也支持json字符串):

:7000/login/qq/csdn?username=number&password=password&format=2

如何使用第二个界面

请求路径:/login/qq

在线地址格式:

注意:注意url编码问题,传入的url可以直接从浏览器地址栏复制过来,如果是自己抓取解析的,注意编码

http://yumbo.top:7000/login/qq?username=qq号&password=qq密码&format=2&url=登录页面的url

如果想看效果,看这篇博客,有gif演示效果:

java+selenium-java实现QQ自动登录并获取cookies

完整的环境搭建流程

如果github不能显示图片,去csdn看我的博客:实现网站的所有QQ登录都返回登录后的cookie信息

原理与实现 第一步在Linux服务器上安装google-chrome(谷歌浏览器)

Centos操作系统的使用如下

下载rpm包

wget https://dl.google.com/linux/di ... 4.rpm

安装依赖

sudo yum install -y lsb

安装

sudo yum localinstall google-chrome-stable_current_x86_64.rpm

对于 Ubuntu 用户,请使用以下命令

以下命令不建议以root身份下载

因为可能会报告权限问题:

N: 下载是作为 root 作为文件'/root/google-chrome-stable_current_amd64.deb' 无法被用户'_apt'访问执行的。-pkgAcquire::Run (13: Permission denied)

下载 deb 包

wget https://dl.google.com/linux/di ... 4.deb

安装 deb 包

sudo apt install -y ./google-chrome-stable_current_amd64.deb

完成后,Centos 和 Ubuntu 将多了一个命令

google-chrome

第二步是下载chromedriver。它的功能是操作google-chrome浏览器,也就是通过它来操作谷歌浏览器

下载链接:

随便选一个,我选的是这个版本:

通过FTP工具上传到linux服务器

ftp 工具如:FileZila 下载页面选择适合你的

或者 xftp

ftp工具和chromedriver也可以通过下面的csdn下载,我是打包成zip包的。您也可以通过选择之前发布的链接自行下载界面

把他上传到一个目录,比如/root

授予执行权限

执行后会出现绿色提示。

chmod 777 chromedriver

第三步,下载jar包,或者自己去github制作一个jar包

jar包下载地址:

需要先修复java环境

对于 Ubuntu: apt install -y openjdk-14-jre-headless 进行安装

Centos: yum install -y java-11-openjdk-devel.x86_64 即可安装(如需配置环境变量可自行配置)

是springboot项目,端口为:7000,可以通过运行参数-Dserver.port修改启动端口

提醒

-Dwebdriver.chrome.driver 是指定驱动器的位置,请改成正确的位置

如果是默认的根目录,可以更改对应的路径

java -jar -Dwebdriver.chrome.driver=/root/chromedriver \

-Dserver.port=7000 autoLoginQQWithAnyWeb-1.0.jar

第四步,发送获取cookie信息的请求

都支持get/post,接收json/pass参数

如下

接口地址:7000/login/{name}

QQ音乐在线地址:7000/登录/音乐

网易云音乐在线地址:7000/登录/网易

csdn在线地址:7000/login/csdn

以下是qq音乐的登录地址(qq音乐不会跳转到后台界面,需要通过抓包来分析)

替换下面的用户名和密码完成登录QQ音乐后获取cookie

复制方便:以下模板只适用于qq音乐,其他网站可以直接复制url代替这个参数的url,根据页面补充如下参数

http://yumbo.top:7000/login/qq/music?username=qq号&password=qq密码&format=2

参数补充说明

以CSDN的登录页面为例,请求地址如下

上面地址之后会跳转到下面的页面(上面的地址会自动跳转到请求授权的页面)

这里有一个过程。该地址的服务器会自动向腾讯的oauth2.0服务器发送请求,然后返回这个统一授权页面。因为这个页面是统一的,所以写了脚本。它会自动点击账号和密码登录===>输入账号和密码==>QQ登录成功后会自动跳转到回调地址,然后在登录后获取cookie成功的

然后我抓住了机会。一般来说,如果我通过上述方式获取url,应该不是拖放验证的步骤。

枚举网站的登录页面地址,然后访问地址,输入用户名和密码登录,登录成功后会自动跳转到登录页面,刷新一次页面,然后得到cookie,并将cookie传输到json Object return {"cookie":"cookie string or native array"}

处理请求的控制器源代码

<p>package top.yumbo.music.test.controller;

import com.alibaba.fastjson.JSONObject;

import org.openqa.selenium.By;

import org.openqa.selenium.Cookie;

import org.openqa.selenium.WebDriver;

import org.openqa.selenium.WebElement;

import org.openqa.selenium.chrome.ChromeDriver;

import org.springframework.util.StringUtils;

import org.springframework.web.bind.annotation.*;

import top.yumbo.music.test.web.WebLoginEnum;

import javax.annotation.Resource;

import java.util.Set;

@RestController

public class LoginController {

@Resource

ChromeDriver chromeDriver;

@Resource

WebDriver.Options manage;

/**

* cookie数据的处理

*

* @param cookies 传入cookie的集合

* @return k1=v1;k2=v2; 这种形式的cookie字符串

*/

private String parseCookieSet(Set cookies) {

if (cookies == null) {

return "";

}

System.out.println("\n解析前cookie是" + cookies.toString());

String cookieString = "";

for (Cookie cookie : cookies) {

if (StringUtils.hasText(cookie.getValue())) {// 为空的cookie则去除

cookieString += (cookie.getName() + "=" + cookie.getValue() + ";");

}

}

System.out.println("解析后:\n" + cookieString);

return cookieString;

}

@GetMapping({"/login/qq/{name}"})

public JSONObject commonLogin(@RequestBody(required = false) JSONObject jsonObject,

@PathVariable(value = "name") String name,

@RequestParam(value = "username", required = false) String username,

@RequestParam(value = "password") String password,

@RequestParam(value = "format", required = false, defaultValue = "1") String format) {

if (StringUtils.hasText(username) && StringUtils.hasText(password)) {

// 什么也不做

} else if (jsonObject != null

&& StringUtils.hasText(jsonObject.getString("username"))

&& StringUtils.hasText(jsonObject.getString("password"))) {

username = jsonObject.getString("username");

password = jsonObject.getString("password");

} else {

final JSONObject error = new JSONObject();

if (jsonObject != null) {

error.put("输入了错误的信息", jsonObject);

} else {

final JSONObject info = new JSONObject();

info.put("username", username);

info.put("password", password);

error.put("输入了错误的信息", info);

}

return error;

}

return LoginAndGetCookie(username, password, name, format);

}

/**

* 登录已知类型的网站

*

* @param username qq账号

* @param password qq密码

* @param name 枚举登录页面的封装类,如果hashMap中没有则这个name就是登录页面的地址

* @param format 返回的cookie类型,1表示原cookie数据,2表示处理后的cookie

* @return json类型的cookie封装类

*/

public JSONObject LoginAndGetCookie(String username, String password, String name, String format) {

final JSONObject cookieJson = new JSONObject();

try {

// 登录前先清除cookie

final String url = WebLoginEnum.getUrl(name);

if (!StringUtils.hasText(url)) {

cookieJson.put("msg", "网站没有引入项目,请使用另外一个接口进行登录");

return cookieJson;

}

manage.deleteAllCookies();// 清除cookie

chromeDriver.get(url);// 访问登录页面

final WebDriver ptlogin_iframe = chromeDriver.switchTo().frame("ptlogin_iframe");

ptlogin_iframe.findElement(By.id("switcher_plogin")).click();

final WebElement u = ptlogin_iframe.findElement(By.className("inputstyle"));

u.clear();// 清空输入的用户名

u.sendKeys(username + "\n");// 输入账号

final WebElement p = ptlogin_iframe.findElement(By.id("p"));

p.clear();// 清空输入的密码数据

p.sendKeys(password + "\n");// 输入密码,回车就提交了下面的这个点击登录不需要

final String beforeUrl = chromeDriver.getCurrentUrl();

while (chromeDriver.getCurrentUrl().equals(beforeUrl)) {

// 页面没有跳转就让他等待,等待自己重定向到登录后的页面,然后再获取cookie时就是正确的cookie

}

System.out.println("=======等待登录成功后跳转到页面

网页qq抓取什么原理(纯JS+HTML+CSS结合的方式-强制浏览器打开 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 72 次浏览 • 2021-10-31 13:10

)

当我们在微信中打开一个链接或二维码时,微信的安全系统会检测到大多数爬虫会抓取我们的页面进行违规。如果这个页面有一点违规,系统会屏蔽这个页面。失去。而且几乎不可能解除封锁。我们这里的宣传链接以前经常遇到这些问题。为了解决这个问题,我们查阅了很多资料,终于找到了一个比较完美的方法——“强制浏览器打开”

案例展示

(请使用微信或QQ打开扫描查看案例)

测试链接:

作者 网站:

技术原理

这次给大家讲一个简化版。采用纯JS+HTML+CSS组合,一共2种操作场景:

1、 用户扫码点击链接打开链接后,会直接弹出遮罩层,强制用户使用浏览器打开!

2、 用户扫码点击链接打开链接后,不会立即弹出提示在新浏览器中打开。只有在点击应用程序下载或其按钮后,才会弹出跳转后提示下载。

部分源代码

点击下载应用

*{margin:0; padding:0;}

a{text-decoration: none;}

img{max-width: 100%; height: auto;}

.weixin-tip{display: none; position: fixed; left:0; top:0; bottom:0; background: rgba(0,0,0,0.8); filter:alpha(opacity=80); height: 100%; width: 100%; z-index: 100;}

.weixin-tip p{text-align: center; margin-top: 10%; padding:0 5%;}

<p>

live_weixin.png

$(window).on("load",function(){

var winHeight = $(window).height();

function is_weixin() {

var ua = navigator.userAgent.toLowerCase();

if (ua.match(/MicroMessenger/i) == "micromessenger") {

return true;

} else {

return false;

}

}

var isWeixin = is_weixin();

if(isWeixin){

$(".weixin-tip").css("height",winHeight);

$(".weixin-tip").show();

}

})

</p>

查看全部

网页qq抓取什么原理(纯JS+HTML+CSS结合的方式-强制浏览器打开

)

当我们在微信中打开一个链接或二维码时,微信的安全系统会检测到大多数爬虫会抓取我们的页面进行违规。如果这个页面有一点违规,系统会屏蔽这个页面。失去。而且几乎不可能解除封锁。我们这里的宣传链接以前经常遇到这些问题。为了解决这个问题,我们查阅了很多资料,终于找到了一个比较完美的方法——“强制浏览器打开”

案例展示

(请使用微信或QQ打开扫描查看案例)

测试链接:

作者 网站:

技术原理

这次给大家讲一个简化版。采用纯JS+HTML+CSS组合,一共2种操作场景:

1、 用户扫码点击链接打开链接后,会直接弹出遮罩层,强制用户使用浏览器打开!

2、 用户扫码点击链接打开链接后,不会立即弹出提示在新浏览器中打开。只有在点击应用程序下载或其按钮后,才会弹出跳转后提示下载。

部分源代码

点击下载应用

*{margin:0; padding:0;}

a{text-decoration: none;}

img{max-width: 100%; height: auto;}

.weixin-tip{display: none; position: fixed; left:0; top:0; bottom:0; background: rgba(0,0,0,0.8); filter:alpha(opacity=80); height: 100%; width: 100%; z-index: 100;}

.weixin-tip p{text-align: center; margin-top: 10%; padding:0 5%;}

<p>

live_weixin.png

$(window).on("load",function(){

var winHeight = $(window).height();

function is_weixin() {

var ua = navigator.userAgent.toLowerCase();

if (ua.match(/MicroMessenger/i) == "micromessenger") {

return true;

} else {

return false;

}

}

var isWeixin = is_weixin();

if(isWeixin){

$(".weixin-tip").css("height",winHeight);

$(".weixin-tip").show();

}

})

</p>

网页qq抓取什么原理(进行SEO的站长首先应该对搜索引擎的抓取、处理、索引的机制分析)

网站优化 • 优采云 发表了文章 • 0 个评论 • 76 次浏览 • 2021-10-31 13:08

做SEO的站长首先要对搜索引擎的工作原理有一定的了解,这样才能更清楚的了解怎么做SEO,以及后面所做的一切对网站优化有什么影响,多一个好的理解度,如何合理优化,如何避免被惩罚。

第一点:分析搜索引擎对内容的抓取、处理和索引的机制

Step 1:第一步,搜索引擎会派蜘蛛爬网,将网上的内容返回到自己的数据库中。

第二步:对检索到的网站进行处理、降噪、提取,提取出网站的主要部分(SNR部分文章上面已经解释过了)。

第三步:对文本内容进行中文分词,去除停用词等无意义内容。

第四步:对页面进行分词处理。搜索引擎将剩余内容与数据库中已有数据进行比较,判断是否存在重复内容,剔除重复页面,对剩余网页进行倒排索引,供用户检索。

第二点:用户搜索、搜索引擎工作流

第一步:前面的关键词文章如何组合关键词的结果来展开关键词,这样用户搜索后,搜索引擎会判断用户所在位置地址、历史检索等方面向用户展示最需要的内容。

第二步:查看缓存中是否有关键词的查询结果。如果有结果,搜索引擎将快速显示结果,它将处理现有数据并将其呈现给用户。

第三步:如果查询到的关键词在缓存中不存在,则检索索引库中的网页并进行排名展示,然后将新的内容放入关键词对应的缓存中@>。

第四步:网页排名的考虑因素主要包括用户的搜索词和搜索需求,然后结合网页在索引中的相关性、权重水平、用户体验进行排名展示。

总结一下:搜索引擎的工作原理就是我刚才提到的。搜索引擎的工作原理大概是综合爬取、处理、分词、去重、索引、内容关联、链接分析、用户体验等各种因素综合考虑,结合用户需求进行排名展示。优质外链 查看全部

网页qq抓取什么原理(进行SEO的站长首先应该对搜索引擎的抓取、处理、索引的机制分析)

做SEO的站长首先要对搜索引擎的工作原理有一定的了解,这样才能更清楚的了解怎么做SEO,以及后面所做的一切对网站优化有什么影响,多一个好的理解度,如何合理优化,如何避免被惩罚。

第一点:分析搜索引擎对内容的抓取、处理和索引的机制

Step 1:第一步,搜索引擎会派蜘蛛爬网,将网上的内容返回到自己的数据库中。

第二步:对检索到的网站进行处理、降噪、提取,提取出网站的主要部分(SNR部分文章上面已经解释过了)。

第三步:对文本内容进行中文分词,去除停用词等无意义内容。

第四步:对页面进行分词处理。搜索引擎将剩余内容与数据库中已有数据进行比较,判断是否存在重复内容,剔除重复页面,对剩余网页进行倒排索引,供用户检索。

第二点:用户搜索、搜索引擎工作流

第一步:前面的关键词文章如何组合关键词的结果来展开关键词,这样用户搜索后,搜索引擎会判断用户所在位置地址、历史检索等方面向用户展示最需要的内容。

第二步:查看缓存中是否有关键词的查询结果。如果有结果,搜索引擎将快速显示结果,它将处理现有数据并将其呈现给用户。

第三步:如果查询到的关键词在缓存中不存在,则检索索引库中的网页并进行排名展示,然后将新的内容放入关键词对应的缓存中@>。

第四步:网页排名的考虑因素主要包括用户的搜索词和搜索需求,然后结合网页在索引中的相关性、权重水平、用户体验进行排名展示。

总结一下:搜索引擎的工作原理就是我刚才提到的。搜索引擎的工作原理大概是综合爬取、处理、分词、去重、索引、内容关联、链接分析、用户体验等各种因素综合考虑,结合用户需求进行排名展示。优质外链

网页qq抓取什么原理(怎么来提升网站的抓取量呢?怎么控制主动抓取时间)

网站优化 • 优采云 发表了文章 • 0 个评论 • 65 次浏览 • 2021-10-24 22:14

网站爬取量是影响网站收录的重要因素,所以控制网站的爬取量非常重要,那么如何提高网站抓取量怎么样?

网站抓取量=网站总抓取时间/网站单页抓取时间

那么自然我们可以从两个维度增加网站的抓取量:

一、减少网站单个页面的抓取时间

对于网站单页的爬取时间,主要是提升(奶粉供应分发)网站的性能,主要包括服务器空间和网站代码的优化,JS 、图片压缩、视频等,提示网站有非常快的打开速度,缩短了搜索引擎程序爬取和下载单个页面的时间,从而访问更多页面,增加爬取量。

二、增加网站的总爬取时间

网站的总爬取时间可分为搜索程序的主动爬取和被动爬取

对于主动爬行,蜘蛛会一直沿着站内某个链接爬行,那么如何控制主动爬行时间呢?

首先,许多链接必须是可抓取的。不要让蜘蛛程序无法识别或没有权限。(有机红酒加盟)比如JS跳转什么的,注册可以访问等,然后网站的物理层和逻辑层简单来说,我们可以把一些重要的页面放在首页缩短物理距离;在逻辑层面上,网站的层次关系要简洁,比如常见的树状结构,首页-栏目页-内容页;最后是内链的设置,将网站相关的内容尽量连成一张网,这样蜘蛛程序就可以轻松爬取。

至于被动爬取,更多是从站外链接的角度来理解。

我们可以在站外建立外链来吸引蜘蛛(皮车的车垫)网站,增加网站的抓取频率和抓取时间,但不要随便去外链做,尝试分享价值。正如百度工程师LEE所说,有推荐值的外链很有用。否则,我们的外链效果会大打折扣,有点跑题了。当然,对于某些人来说,有总比没有好。

需要引起您注意的另一点是允许爬取蜘蛛程序。这涉及到robots 文件的设置。其次,很多网站都会有反采集系统,有些服务器有防火墙。,以及日志的HTTP状态码,这些都会影响蜘蛛对网页的抓取,进而影响收录和流量。

从上面的公式,基本上可以看出大致的方式了。(妈妈三好)网站如何增加抓包量?无非是减少分母和增加分子。无痕在这里只是简单的陈述。一些感悟,更多知识可以去看看国平前辈的相关分享,谢谢。 查看全部

网页qq抓取什么原理(怎么来提升网站的抓取量呢?怎么控制主动抓取时间)

网站爬取量是影响网站收录的重要因素,所以控制网站的爬取量非常重要,那么如何提高网站抓取量怎么样?

网站抓取量=网站总抓取时间/网站单页抓取时间

那么自然我们可以从两个维度增加网站的抓取量:

一、减少网站单个页面的抓取时间

对于网站单页的爬取时间,主要是提升(奶粉供应分发)网站的性能,主要包括服务器空间和网站代码的优化,JS 、图片压缩、视频等,提示网站有非常快的打开速度,缩短了搜索引擎程序爬取和下载单个页面的时间,从而访问更多页面,增加爬取量。

二、增加网站的总爬取时间

网站的总爬取时间可分为搜索程序的主动爬取和被动爬取

对于主动爬行,蜘蛛会一直沿着站内某个链接爬行,那么如何控制主动爬行时间呢?

首先,许多链接必须是可抓取的。不要让蜘蛛程序无法识别或没有权限。(有机红酒加盟)比如JS跳转什么的,注册可以访问等,然后网站的物理层和逻辑层简单来说,我们可以把一些重要的页面放在首页缩短物理距离;在逻辑层面上,网站的层次关系要简洁,比如常见的树状结构,首页-栏目页-内容页;最后是内链的设置,将网站相关的内容尽量连成一张网,这样蜘蛛程序就可以轻松爬取。

至于被动爬取,更多是从站外链接的角度来理解。

我们可以在站外建立外链来吸引蜘蛛(皮车的车垫)网站,增加网站的抓取频率和抓取时间,但不要随便去外链做,尝试分享价值。正如百度工程师LEE所说,有推荐值的外链很有用。否则,我们的外链效果会大打折扣,有点跑题了。当然,对于某些人来说,有总比没有好。

需要引起您注意的另一点是允许爬取蜘蛛程序。这涉及到robots 文件的设置。其次,很多网站都会有反采集系统,有些服务器有防火墙。,以及日志的HTTP状态码,这些都会影响蜘蛛对网页的抓取,进而影响收录和流量。

从上面的公式,基本上可以看出大致的方式了。(妈妈三好)网站如何增加抓包量?无非是减少分母和增加分子。无痕在这里只是简单的陈述。一些感悟,更多知识可以去看看国平前辈的相关分享,谢谢。

网页qq抓取什么原理(网页qq抓取什么原理?从技术角度,抓取微信qq)

网站优化 • 优采云 发表了文章 • 0 个评论 • 67 次浏览 • 2021-10-23 02:03

网页qq抓取什么原理?从技术角度,抓取微信qq这类网页不需要获取其qq号和邮箱号码。所以直接明了的说,网页版本的自身的处理就会把微信qq显示出来的qq号和邮箱列表分开来显示,人工也很难改变。所以这就是qq号和邮箱列表分开显示的原因。从业务角度分析,获取微信qq信息完全可以通过人工实现,因为大多数人都可以帮助通过很小的代价提取他qq或者邮箱中的邮件和密码,比较耗时耗力的就是显示一个qq邮箱列表而已。

并且获取微信qq这类账号需要进行强烈的验证(注册时提供的手机号,曾用绑定qq等)。就是说不可能是人工对一封新发送的微信或者qq邮件做排序,而是依据用户已有的帐号,开始依次进行搜索。而这些可以通过好友验证、新增、帐号验证等服务完成。从业务角度分析,还可以做一个退一步的处理。就是如果没有好友验证或者没有新增过好友怎么办?是可以通过人工或者认证的网站做一个筛选。

就是如果不在好友验证范围内的帐号发送了邮件或者其他数据源,都会被自动过滤掉。然后没有被过滤掉的将会转发给他人服务器提取收据,等确认提取到相关信息时才显示相关信息。大多数网站都是这么做的。

没有密码一般是加密过的,你都知道密码,就好办多了啊。我一般都是,我今天能卖货,你能查到我的号码么。 查看全部

网页qq抓取什么原理(网页qq抓取什么原理?从技术角度,抓取微信qq)

网页qq抓取什么原理?从技术角度,抓取微信qq这类网页不需要获取其qq号和邮箱号码。所以直接明了的说,网页版本的自身的处理就会把微信qq显示出来的qq号和邮箱列表分开来显示,人工也很难改变。所以这就是qq号和邮箱列表分开显示的原因。从业务角度分析,获取微信qq信息完全可以通过人工实现,因为大多数人都可以帮助通过很小的代价提取他qq或者邮箱中的邮件和密码,比较耗时耗力的就是显示一个qq邮箱列表而已。

并且获取微信qq这类账号需要进行强烈的验证(注册时提供的手机号,曾用绑定qq等)。就是说不可能是人工对一封新发送的微信或者qq邮件做排序,而是依据用户已有的帐号,开始依次进行搜索。而这些可以通过好友验证、新增、帐号验证等服务完成。从业务角度分析,还可以做一个退一步的处理。就是如果没有好友验证或者没有新增过好友怎么办?是可以通过人工或者认证的网站做一个筛选。

就是如果不在好友验证范围内的帐号发送了邮件或者其他数据源,都会被自动过滤掉。然后没有被过滤掉的将会转发给他人服务器提取收据,等确认提取到相关信息时才显示相关信息。大多数网站都是这么做的。

没有密码一般是加密过的,你都知道密码,就好办多了啊。我一般都是,我今天能卖货,你能查到我的号码么。

网页qq抓取什么原理(无论搜索引擎的收录原理是什么?如何快速解决的问题)

网站优化 • 优采云 发表了文章 • 0 个评论 • 143 次浏览 • 2021-10-23 00:13

相信有很多知识的人都明白搜索引擎的善变,无法真正理解搜索的工作原理,但无论搜索引擎如何变化,收录的大体原理都不会改变:

1、找到网站的网址,下载页面。

2、 判断页面质量是否符合收录标准收录页面,否则删除。

3、 判断收录页面是否更新,更新页面快照。

此外,搜索引擎可以分为五个基本部分,包括网络爬虫系统、数据分析系统、数据存储系统、缓存系统和显示系统。

1、 网络爬虫系统:分为检测系统和下载系统。检测系统就是我们通常所说的蜘蛛。当蜘蛛在网上爬行时检测到网站的URL,就会指向该URL 使用下载系统将搜索引擎的页面下载到搜索引擎的服务器,然后将页面交给数据分析系统。

2、数据分析系统:分为数据分析和数据处理两个系统。当数据分析系统从网络爬虫系统获取下载的页面时,首先进行数据分析,去除不相关的文本或网站重复的内容,对页面文本进行处理,然后判断处理后的页面内容,是否满足收录 标准,交给存储系统,但不删除。

3、存储数据系统:保存收录的页面,然后定期判断存储的页面是否有更新。

4、缓存系统:存储搜索引擎认为的高价值内容。当用户搜索某个关键词时,经常会看到收录的数量是几千万,而搜索引擎却只显示了1000条。,这意味着只有1000个项目放在缓存系统上,用户可以最快的速度找到他们想要的内容。

5、显示系统:用户搜索返回显示的信息。

蜘蛛在网上爬行,遇到一个你的网站的URL,先把这个URL根据网站的权重和相关性提取出来插入到URL队列中,然后判断你的网站@ > 网址是否能解析成功,如果能解析成功,蜘蛛会爬到你身上网站,这里需要说一下,蜘蛛不是直接分析你的网页内容,而是找到你的网站robots 文件,根据你的网站 robots规则判断是否抓取你的页面,如果robots文件不存在,会返回404错误,但搜索引擎会继续抓取你的页面网站 内容。

所以只要我们能很好地理解它的工作原理,我们就可以相对轻松地进行网站优化。 查看全部

网页qq抓取什么原理(无论搜索引擎的收录原理是什么?如何快速解决的问题)

相信有很多知识的人都明白搜索引擎的善变,无法真正理解搜索的工作原理,但无论搜索引擎如何变化,收录的大体原理都不会改变:

1、找到网站的网址,下载页面。

2、 判断页面质量是否符合收录标准收录页面,否则删除。

3、 判断收录页面是否更新,更新页面快照。

此外,搜索引擎可以分为五个基本部分,包括网络爬虫系统、数据分析系统、数据存储系统、缓存系统和显示系统。

1、 网络爬虫系统:分为检测系统和下载系统。检测系统就是我们通常所说的蜘蛛。当蜘蛛在网上爬行时检测到网站的URL,就会指向该URL 使用下载系统将搜索引擎的页面下载到搜索引擎的服务器,然后将页面交给数据分析系统。

2、数据分析系统:分为数据分析和数据处理两个系统。当数据分析系统从网络爬虫系统获取下载的页面时,首先进行数据分析,去除不相关的文本或网站重复的内容,对页面文本进行处理,然后判断处理后的页面内容,是否满足收录 标准,交给存储系统,但不删除。

3、存储数据系统:保存收录的页面,然后定期判断存储的页面是否有更新。

4、缓存系统:存储搜索引擎认为的高价值内容。当用户搜索某个关键词时,经常会看到收录的数量是几千万,而搜索引擎却只显示了1000条。,这意味着只有1000个项目放在缓存系统上,用户可以最快的速度找到他们想要的内容。

5、显示系统:用户搜索返回显示的信息。

蜘蛛在网上爬行,遇到一个你的网站的URL,先把这个URL根据网站的权重和相关性提取出来插入到URL队列中,然后判断你的网站@ > 网址是否能解析成功,如果能解析成功,蜘蛛会爬到你身上网站,这里需要说一下,蜘蛛不是直接分析你的网页内容,而是找到你的网站robots 文件,根据你的网站 robots规则判断是否抓取你的页面,如果robots文件不存在,会返回404错误,但搜索引擎会继续抓取你的页面网站 内容。

所以只要我们能很好地理解它的工作原理,我们就可以相对轻松地进行网站优化。

网页qq抓取什么原理(如何让访客访问您网站时自动弹出QQ聊天的对话框)

网站优化 • 优采云 发表了文章 • 0 个评论 • 116 次浏览 • 2021-10-21 04:06

伊恩今天不小心进入了一家公司的企业网站,QQ聊天窗口立马弹出窗口和那家公司的客服聊天。怀着好奇的心情,伊恩分析了公司网站的源代码,发现了网页弹出QQ对话框的原理和实现方法。相信此时此刻,你的QQ已经打开了和伊恩的聊天窗口吧?!ian在这里把实现“网页QQ对话框自动弹出”的原理和方法分享给所有商务朋友网站。这些小方法可以与“在认证QQ空间首页显示网站”内容同步,对网站的推广也有比较有用的效果。自动弹出QQ对话框的方法可以实现大量的客户查询。相比“左一右一再中一”的客服组件,“打开网页自动弹出QQ对话框”的方式实现咨询量的增加,用户体验和效果要强得多。好了,废话不多说,下面进入正题,看看如何让访问者访问你时自动弹出QQ聊天对话框网站。一、网页自动弹出QQ对话框的原理1.在网页中插入一个iframe框架并设置src="tencent://message/?uin=你的QQ号&Site=&menu=yes ";2. 当访问者打开你网站时,也会打开iframe框架中的链接;3. 访问者的QQ窗口会弹出一个对话框与您的QQ聊天。二、验证打开网页时QQ对话框自动弹出。为了验证这个方法的实际可行性,相信你的QQ聊天窗口已经打开了和Ian对话的聊天窗口。

你好奇吗?如果你对上面的原理分析没看懂,那么这里的验证结果应该能让你直观的理解!其实Ian也是利用这个原理在这个文章中添加了一段实现“打开网页时自动弹出QQ对话框”的代码。打开网页自动弹出QQ对话框的代码在这里:【点右键查看源码,或者点这里捐给我】三、设置多个QQ客服,然后随机弹出公司客服QQ对话框 多个客服的情况下,直接合理分配接待客服。伊恩刚想出一个办法,就是预设多个客服QQ,然后随机弹出一个客服QQ对话框给访客!当然,这适用于企业,但对于个人站长来说不是必需的。四、 延迟弹出对话框,让用户先看到。很多客户问我如何设置访问者打开页面10秒后弹出。伊恩再次研究并更新了这个弹出窗口。我确实找到了一种可以设置为 10 秒后弹出的方法。!这样可以在一定程度上提升用户体验,同时让访问者首先看到网站的优质服务可以有效提升客户对产品的认可度,从而增加客户对产品的认知度。积极沟通!五、手机QQ也可以用,手机用户不要错过。刚有朋友问我这个能不能用在手机网页上,Ian测试了这个方法不行。之后研究了一段时间,终于找到了手机网页上手机QQ弹窗的突破点。经测试,无论是安卓手机还是苹果手机都可以正常弹出QQ对话框。

六、获取访客QQ,让客服主动掌握客户。通过上面的方法,有朋友说客户打开对话框后没有咨询就直接出去吃饭了,回来的时候忘记了。对此,伊恩还文章扩展想到了访问者访问网站时自动获取QQ号的方法,这种方法可以避免访问者的流失,即使访问者没有咨询也没有交易,没关系,你知道客户QQ号,以后可以随时给对方发消息。有需要的朋友可以在聊天窗口点击Qian。 查看全部

网页qq抓取什么原理(如何让访客访问您网站时自动弹出QQ聊天的对话框)