网页抓取工具

飞侠网络快递查询:国内开发者开发的chrome网页抓取神器

网站优化 • 优采云 发表了文章 • 0 个评论 • 100 次浏览 • 2022-05-06 19:00

网页抓取工具有很多,我一般都会推荐谷歌浏览器,首先这款浏览器适用人群多,且网页抓取方便,安全,大部分情况都能满足。要说其他什么扩展之类的比如chrome扩展真的很少用到。推荐一款国内开发者开发的chrome网页抓取神器,真正把网页抓取做到了极致!飞侠网络快递查询:,除了最常用的快递查询,还支持api接口,可以实现多种接口。

我记得我前面推荐用自己的系统抓取微信公众号上面的文章是免费,是因为不想让别人免费用我的系统,但是现在有强制收费,网络里面和最后一根电缆上都是干脆利落的收费模式,我觉得不舒服,并且也不是每个免费服务都值得。所以这里给大家推荐开源的网页抓取工具,喜欢的可以去下载使用一下。另外,近期也有一个微信公众号正好在搞活动,里面带有大量的平台工具,方便大家查找,也推荐一下。

经过很长时间的思考,觉得比较好用的有dreamwingpagegenerator。不知道算不算是第一抓取网站工具,但我真的觉得很好用啊。首先一个功能就是获取历史网页。我很久没关注网页抓取了,今天刚抓了几页大家感受一下。任何网站都有往期文章/回顾,一般每篇文章末尾都会有链接让你看看近期文章。所以这些文章的历史版本可以通过dreamwing获取到。

这样我们就不用再搜各个网站的历史版本了。我们可以在搜索框输入我们需要的文章关键词,得到近期文章列表。并且通过链接,指向之前提供给我们文章的网站。这样就可以继续抓取下一个长尾关键词。fullspacewebservice(dws)就可以抓取这个。然后还有要了解的一个功能是文章关键词匹配。就是说网站上发布的文章,同一篇可能同一作者不同时间不同网站发布的内容都会获取到。

因为一般网站的维护时间是很长的,发布了一篇文章并不代表就删除掉了。我们也可以通过更新文章的时间去判断。这样就可以获取到新发布的链接,还可以解析链接内容,帮助自己抓取那些长尾文章。还有就是我觉得是非常非常方便的一个功能。就是我们可以对同一篇文章修改标题以及最后的网站地址进行变更,这样可以让之前的很多长尾网站内容进行重复抓取。

就像上面这个例子。我之前做事情喜欢养成好习惯,就是去一个网站看看人家的快递怎么抓,看看别人的返图,然后上美团买自己想吃的东西,之后再找个自己觉得不错的餐馆点个酒吃吃。其实我自己也不清楚他们有什么规则。只知道别人会每天有各种活动会发布商品信息。别人也是这样的,所以其实很多好不错的东西,大部分我都看不到。所以,我觉得可以通过那些隐藏的蛛丝马迹,找到很多我们自己想吃的东西。 查看全部

飞侠网络快递查询:国内开发者开发的chrome网页抓取神器

网页抓取工具有很多,我一般都会推荐谷歌浏览器,首先这款浏览器适用人群多,且网页抓取方便,安全,大部分情况都能满足。要说其他什么扩展之类的比如chrome扩展真的很少用到。推荐一款国内开发者开发的chrome网页抓取神器,真正把网页抓取做到了极致!飞侠网络快递查询:,除了最常用的快递查询,还支持api接口,可以实现多种接口。

我记得我前面推荐用自己的系统抓取微信公众号上面的文章是免费,是因为不想让别人免费用我的系统,但是现在有强制收费,网络里面和最后一根电缆上都是干脆利落的收费模式,我觉得不舒服,并且也不是每个免费服务都值得。所以这里给大家推荐开源的网页抓取工具,喜欢的可以去下载使用一下。另外,近期也有一个微信公众号正好在搞活动,里面带有大量的平台工具,方便大家查找,也推荐一下。

经过很长时间的思考,觉得比较好用的有dreamwingpagegenerator。不知道算不算是第一抓取网站工具,但我真的觉得很好用啊。首先一个功能就是获取历史网页。我很久没关注网页抓取了,今天刚抓了几页大家感受一下。任何网站都有往期文章/回顾,一般每篇文章末尾都会有链接让你看看近期文章。所以这些文章的历史版本可以通过dreamwing获取到。

这样我们就不用再搜各个网站的历史版本了。我们可以在搜索框输入我们需要的文章关键词,得到近期文章列表。并且通过链接,指向之前提供给我们文章的网站。这样就可以继续抓取下一个长尾关键词。fullspacewebservice(dws)就可以抓取这个。然后还有要了解的一个功能是文章关键词匹配。就是说网站上发布的文章,同一篇可能同一作者不同时间不同网站发布的内容都会获取到。

因为一般网站的维护时间是很长的,发布了一篇文章并不代表就删除掉了。我们也可以通过更新文章的时间去判断。这样就可以获取到新发布的链接,还可以解析链接内容,帮助自己抓取那些长尾文章。还有就是我觉得是非常非常方便的一个功能。就是我们可以对同一篇文章修改标题以及最后的网站地址进行变更,这样可以让之前的很多长尾网站内容进行重复抓取。

就像上面这个例子。我之前做事情喜欢养成好习惯,就是去一个网站看看人家的快递怎么抓,看看别人的返图,然后上美团买自己想吃的东西,之后再找个自己觉得不错的餐馆点个酒吃吃。其实我自己也不清楚他们有什么规则。只知道别人会每天有各种活动会发布商品信息。别人也是这样的,所以其实很多好不错的东西,大部分我都看不到。所以,我觉得可以通过那些隐藏的蛛丝马迹,找到很多我们自己想吃的东西。

【盘点】七个常用的网页数据抽取工具

网站优化 • 优采云 发表了文章 • 0 个评论 • 117 次浏览 • 2022-05-05 05:11

作为大数据从业工作者和科研人员,很多时候需要从网页中获取数据。如果不想自己编写爬虫程序,就可以使用一些专业的网页数据抽取工具来达到这一目的。接下来小编就为你盘点下七个常用的网页数据抽取工具。

1. Import.io

该工具是一款无需客户端的抓取工具,一切工作在浏览器中即可进行,操作便捷简单,爬取数据后可在可视化界面对其进行筛选。

2. Parsehub

这款工具需要下载客户端进行操作,该工具打开后类似一个浏览器,输入网址后便可进行数据提取,支持Windows、MacOS、Linux操作系统。

3. Web Scraper

这款工具是一款基于Chrome浏览器的插件,可以直接通过谷歌应用商店免费获取并安装,可以轻松抓取静态网页和js动态加载网页。

想具体了解如何使用这个工具,可以参考下面这个教程:有关webscraper的问题,看这个就够了

4. 80legs

该工具的背后是5万台计算机构成的Plura网格,功能强大,但更多的是为企业级客户服务,商业用途明显,监控能力很强,价格也较为昂贵。

5. 优采云采集器

该工具目前是国内最为成熟的网页数据采集工具,需要下载客户端,在客户端内可进行可视化数据抓取。该工具也同时具有国际版的Octoparse软件。根据采集能力,该工具分为免费版、专业版、旗舰版、私有云、企业定制版这5个版本,价格从每年0到69800元不等,免费版虽然可以免费采集,但是数据导出需要额外付费。

6. 造数

这是一款起步虽晚但有着较高爬取效率的企业向基于网页的云爬取工具,无需额外下载客户端。

7. 优采云采集器

这是国内的老牌采集器公司,商业化很早,但学习成本较高,规则制定较为复杂。收费方式为软件收费,旗舰版价格为千元左右,付费后无限制。 查看全部

【盘点】七个常用的网页数据抽取工具

作为大数据从业工作者和科研人员,很多时候需要从网页中获取数据。如果不想自己编写爬虫程序,就可以使用一些专业的网页数据抽取工具来达到这一目的。接下来小编就为你盘点下七个常用的网页数据抽取工具。

1. Import.io

该工具是一款无需客户端的抓取工具,一切工作在浏览器中即可进行,操作便捷简单,爬取数据后可在可视化界面对其进行筛选。

2. Parsehub

这款工具需要下载客户端进行操作,该工具打开后类似一个浏览器,输入网址后便可进行数据提取,支持Windows、MacOS、Linux操作系统。

3. Web Scraper

这款工具是一款基于Chrome浏览器的插件,可以直接通过谷歌应用商店免费获取并安装,可以轻松抓取静态网页和js动态加载网页。

想具体了解如何使用这个工具,可以参考下面这个教程:有关webscraper的问题,看这个就够了

4. 80legs

该工具的背后是5万台计算机构成的Plura网格,功能强大,但更多的是为企业级客户服务,商业用途明显,监控能力很强,价格也较为昂贵。

5. 优采云采集器

该工具目前是国内最为成熟的网页数据采集工具,需要下载客户端,在客户端内可进行可视化数据抓取。该工具也同时具有国际版的Octoparse软件。根据采集能力,该工具分为免费版、专业版、旗舰版、私有云、企业定制版这5个版本,价格从每年0到69800元不等,免费版虽然可以免费采集,但是数据导出需要额外付费。

6. 造数

这是一款起步虽晚但有着较高爬取效率的企业向基于网页的云爬取工具,无需额外下载客户端。

7. 优采云采集器

这是国内的老牌采集器公司,商业化很早,但学习成本较高,规则制定较为复杂。收费方式为软件收费,旗舰版价格为千元左右,付费后无限制。

关于制作网页导航这件事

网站优化 • 优采云 发表了文章 • 0 个评论 • 72 次浏览 • 2022-04-30 16:00

小唐学化学

过去一周由于疫情防控的需要,校园进行了封楼管理。利用在宿舍的空余时间,我收集汇总了自己在过去几年经常用到的网页。主要涵盖科研论文获取、论文写作、常用软件下载以及部分能够提高工作效率的小工具,网页导航还在进一步更新中。下面主要介绍一下这些网址的作用:

小工具

这个部分主要是一些能够提高工作效率的小工具。I Love Pdf 是一个可以在线编辑PDF文件的网页,包括但不限于PDF合并、PDF分割、PDF转jpg等等。在线抠图可以快速抓取图片中的主体内容,将日常实验室实验照片进行扣取,用于PPT汇报让人感觉更加正式。b站下载可以复制b站上面的网页地址进行直接下载。脚本获取主要是针对谷歌浏览器、Edge浏览器的脚本下载。

文献获取

这个部分主要是对日常使用到的文献搜集数据库进行整合。其中包括最常用的Web of Science、中国知网、万方等,此外还添加了DOI一键获取论文、SCI-hub等大家耳熟能详的论文下载方式。

论文写作

这个部分主要包括了论文写作过程中的翻译、语法检测、降重与改写。前面几个翻译工具大家应该是最常用到的,其中我认为DeepL和知网翻译相对符合论文写作或者阅读的思维。写作过程中,对于需要缩写的术语或专业名词可以参考术语在线等工具。后面还有一些语法检查、降重改写的工具。可以先结合这些工具给的建议进行选择性采纳,最后根据自己的理解做最后的修改,之前参加美赛的时候,大致思路就是先写英式中文,把语句尽量写短,写精炼。然后用翻译软件来回的中译英、英译中检查大致意思有没有翻译错误,接着使用语法检测软件来回修改几次,查重降重,最后提交。SCI结构示范里面给了很多引言、方法、结论的模板,可以适当参考。

其他

后面还有三个部分主要是我们课题组用的相对多一些。权威数据获取里面主要是一些晶体数据获取的网址,例如CCDC或者COD等。软件安装的话为了节省时间以及方便日后维护,直接搭乘的是几个公众号平台的便车,一键直达。里面有绝大部分化学类研究生需要用到的软件,课题组常用分组里面是一些校内的网址,例如仪器预约、网上报销等等。欢迎大家体验。网址如下,微信平台打不开,需要复制到浏览器或者电脑网页打开。

小唐学化学:

查看全部

关于制作网页导航这件事

小唐学化学

过去一周由于疫情防控的需要,校园进行了封楼管理。利用在宿舍的空余时间,我收集汇总了自己在过去几年经常用到的网页。主要涵盖科研论文获取、论文写作、常用软件下载以及部分能够提高工作效率的小工具,网页导航还在进一步更新中。下面主要介绍一下这些网址的作用:

小工具

这个部分主要是一些能够提高工作效率的小工具。I Love Pdf 是一个可以在线编辑PDF文件的网页,包括但不限于PDF合并、PDF分割、PDF转jpg等等。在线抠图可以快速抓取图片中的主体内容,将日常实验室实验照片进行扣取,用于PPT汇报让人感觉更加正式。b站下载可以复制b站上面的网页地址进行直接下载。脚本获取主要是针对谷歌浏览器、Edge浏览器的脚本下载。

文献获取

这个部分主要是对日常使用到的文献搜集数据库进行整合。其中包括最常用的Web of Science、中国知网、万方等,此外还添加了DOI一键获取论文、SCI-hub等大家耳熟能详的论文下载方式。

论文写作

这个部分主要包括了论文写作过程中的翻译、语法检测、降重与改写。前面几个翻译工具大家应该是最常用到的,其中我认为DeepL和知网翻译相对符合论文写作或者阅读的思维。写作过程中,对于需要缩写的术语或专业名词可以参考术语在线等工具。后面还有一些语法检查、降重改写的工具。可以先结合这些工具给的建议进行选择性采纳,最后根据自己的理解做最后的修改,之前参加美赛的时候,大致思路就是先写英式中文,把语句尽量写短,写精炼。然后用翻译软件来回的中译英、英译中检查大致意思有没有翻译错误,接着使用语法检测软件来回修改几次,查重降重,最后提交。SCI结构示范里面给了很多引言、方法、结论的模板,可以适当参考。

其他

后面还有三个部分主要是我们课题组用的相对多一些。权威数据获取里面主要是一些晶体数据获取的网址,例如CCDC或者COD等。软件安装的话为了节省时间以及方便日后维护,直接搭乘的是几个公众号平台的便车,一键直达。里面有绝大部分化学类研究生需要用到的软件,课题组常用分组里面是一些校内的网址,例如仪器预约、网上报销等等。欢迎大家体验。网址如下,微信平台打不开,需要复制到浏览器或者电脑网页打开。

小唐学化学:

安利学习软件!商院学生必看!

网站优化 • 优采云 发表了文章 • 0 个评论 • 83 次浏览 • 2022-04-30 15:31

目前,人工智能、互联网、大数据、云计算等技术在财会领域的应用越来越广泛,这也必要求会计人员懂技术。而对于财会类专业学生而言,我们首先需要熟练掌握一些基本的软件,比如办公软件、数据统计与分析软件、云笔记、思维导图、制图软件等,通过使用各类软件以提高学习与工作的效率!

01基本办公软件

Word、Excel、PPT

Microsoft Office系列或者WPS系列中的Word、Excel、PPT,对于财会类专业的学生和会计工作人员而言,都是必不可少的基本办公软件。

02数据统计与分析软件

SPSSStatistica、Eviews、

Matlab、Stata、SAS、R、Python

(图源:网络)

目前,Python是一款最热、功能齐全的软件了,强烈推荐!特别是对编程语言有一定基础的同学更得心应手。不过,SPSS Statistica、Eviews、Matlab、Stata、SAS、R、Python这几款软件也是各有特色的!

对于编程知识薄弱的同学而言,只需要基础统计学知识,就可以操作SPSS。SPSS具有非常强的统计分析功能,如相关分析、回归分析、聚类分析、生存分析等;适合于为计量分析做事前处理,如多元变量降维,数据收集、整合、假设检验等等工作。在回归分析方面,spss能力相对于其他软件而言,不够全面和方便。在此,向大家推荐SPSS 22以上版本。

Eviews是专门为大型机构开发的、用以处理时间序列数据的时间序列软件包的新版本。

Matlab主要用于算法开发、数据可视化、数据分析以及数值计算的高级技术计算语言和交互式环境,它具有友好的用户界面及接近数学表达式的自然化语言,使学者易于学习和掌握;具有完备的图形处理功能,实现计算结果和编程的可视化。但是,Matlab的速度有些慢。

SAS提供了从基本统计数的计算到各种试验设计的方差分析,相关回归分析以及多变数分析的多种统计分析过程,几乎囊括了所有最新分析方法,其分析技术先进,可靠;使用简便,操作灵活;其编程语句简洁,短小,通常只需很小的几句语句即可完成一些复杂的运算,得到满意的结果。

Stata其统计分析能力超过了SPSS,在许多方面也超过了SAS,由于Stata在分析时是将数据全部读入内存,在计算全部完成后才和磁盘交换数据,因此计算速度极快。

一般来说, SAS的运算速度要比SPSS至少快一个数量级,而Stata的某些模块和执行同样功能的SAS模块比,其速度又比SAS快将近一个数量级!

R语言属于GNU系统的一个自由、免费、源代码开放的软件,它是一个用于统计计算和统计制图的优秀工具,制图具有印刷的素质,也可加入数学符号;具有一套源自S语言,完善、简单、有效的编程语言(包括条件、循环、自定义函数、输入输出功能)。

Python为什么如此热门,除了有很强的数据统计与分析的功能,还具有Web 和 Internet开发,网络爬虫等功能。

首先,众多开源的科学计算库都提供了Python的调用接口;用户可以在任何计算机上免费安装Python及其绝大多数扩展库。

其次,与Matlab相比,Python是一门更易学、更严谨的程序设计语言。它能让用户编写出更易读、易维护的代码。

最后,Python有着丰富的扩展库,比如scrapy 爬虫框架、sklearn 机器学习、tensorflow 深度学习,可以轻易完成各种高级任务,开发者可以用Python实现完整应用程序所需的各种功能。

03云笔记

为知笔记、有道云笔记

(图源:网络)

云笔记方便你随时收录与整理文件与网页内容;配合思维导图软件使用,效果更好。为知笔记、有道云笔记通常具有这些优点:

分类整理笔记,高效管理个人知识,快速搜索,分类查找,安全备份云端笔记,存储永不丢失的珍贵资料。

文件同步自动完成——自动同步,无需拷贝下载;支持图片及文档类附件,无限增长的大存储空间。

随时随地记录一切趣事和想法:轻松与电脑双向同步。

精彩网页一键保存——一键保存网页中精彩图文,再也不会遗漏。

手写输入——用手指直接在屏幕上输入,保留手写原笔迹;

涂鸦——轻松、有趣的随手涂鸦,绘制您所想。

04思维导图

Mind Manager、X Mind、

MindMaster、Mind line

(图源:网络)

无论是学习还是工作中,比如写一篇论文、做一次演讲,我们经常需要整理自己的思路,那么思维导图软件是帮助我们理清思路、头脑风暴、抓住灵感最好的工具了;思维导图在搭建知识构架方面也是非常有用的。

Mind Manager是行业中最专业、逼格最高的,但是目前网上你几乎找不到免费版本;X Mind则是免费的,绝对够用;国产的亿图思维导图软件MindMaster也可以也免费。

Mind Manager、X Mind、MindMaster、Mind line这几款的功能很接近,特别推荐X Mind,X Mind 提供各种结构图,比如鱼骨图、矩阵图、时间轴、组织结构图等来帮你更好地理清复杂的想法和事项。这些多种视觉化的思维呈现方式让你能进行深度的对比分析,更直观地进行里程碑的记录和事项的安排。

05文献阅读器

PDF、超星阅读器、CAJ阅读器

有人喜欢Adobe Acrobat Reader,有人采用福昕pdf阅读器,但注意的是做科研的,当然要用专业版本的。

其中,Adobe AcrobatReader要专业版本,福昕要福昕pdf高级编辑器,这些版本的软件功能才会全面,解决pdf的常见需求,比如标记功能、pdf页面管理功能(把图片、word、excel等文件自由地组合到原有pdf文件中去)。

此外,学校往往会购买超星和知网数据库,而超星的电子书籍需要下载超星阅读器才可以看,知网的部分文献,尤其是硕博士论文,需要用官方的CAJ阅读器查看。

06文献管理器

NoteExpress、Mendeley、

E-study、Endnote

NoteExpress是国内专业的文献检索与管理系统,其核心功能是帮助读者高效利用文献,收集并管理得到的文献元数据和全文,帮助科研工作者提高工作效率,此款是比较推荐的!

Mendeley是一款免费的文献管理软件,有一键抓取网页上的文本添加到个人library中的功能,安装插件后还可以编辑文本。

E-study是中国知网的一个附属功能软件,使用方便,能同步下载知网上的论文。

Endnote是汤森路透的老牌文献管理软件,目前最新版是Endnote X9.2,Endnote的文献去重复功能比较突出,但有时候中文支持也不太好。

07科研作图软件

Origin、SigmaPlot、PS、Matlab、R

Origin是国际出版界公认的标准数据处理与科学绘图软件,是一款定位于基础和专业之间的作图软件。它的界面简单,操作也容易入门和掌握。但是,相比于Excel作图,Origin又为我们提供了非常多样的数据图表制作样式以及自定义编辑。

SigmaPlot的功能与Origin非常类似,但是在操作的易用性上会更好,某些样式的图导出后比Origin效果要好,可以与Origin互补。

Adobe photoshop(PS)这个很多时候用来组图,添加点标志,其应用广泛,业余时可以学习ps教程。

此外,Matlab、R也有很强大的作图功能,通过编程实现。比如R语言中也可以实现气泡图、箱线图、专业曲线图的绘制。

08流程图

Visio、ProcessOn

(图源:网络)

在一些论文里面,需要画流程图或者技术路线图,图形能直观体现论文框架或者某个思路,虽然Word里面可制作简单的流程图,但是没有专门的流程图制作软件方便,而且Visio等里面更多的多种功能。

Office Visio 是office软件系列中的负责绘制流程图和示意图的软件,是一款对复杂信息、系统和流程进行可视化处理、分析和交流的软件;具有专业外观的 Office Visio 图表。

ProcessOn是一个在线作图工具的聚合平台,它可以在线画流程图、思维导图、UI原型图、UML、网络拓扑图、组织结构图等等。

09翻译工具

google翻译、CNKI翻译助手、有道翻译

翻译工具的功能基本差不多,其中,CNKI翻译助手中呈现出的例句与词汇均出于学术期刊,而且大多可以追索到对应文献原文;可以帮助搜索到一些专业术语,了解常规表达与用法,顺带着还可以看看国内外相关领域的文献。

小伙伴们对财会证书有备考需求的话,可以关注抖音号!抖主不定时上传CPA方向班老师们的课程,供大家在休闲的时候学习观看!

扫描上方二维码,添加助教老师微信!领取学习礼包!添加时备注:专业+姓名!想要了解注会的报考条件、考试科目、就业方向、学习方法等,记得跟教务老师申请咨询注会的时间哦! 查看全部

安利学习软件!商院学生必看!

目前,人工智能、互联网、大数据、云计算等技术在财会领域的应用越来越广泛,这也必要求会计人员懂技术。而对于财会类专业学生而言,我们首先需要熟练掌握一些基本的软件,比如办公软件、数据统计与分析软件、云笔记、思维导图、制图软件等,通过使用各类软件以提高学习与工作的效率!

01基本办公软件

Word、Excel、PPT

Microsoft Office系列或者WPS系列中的Word、Excel、PPT,对于财会类专业的学生和会计工作人员而言,都是必不可少的基本办公软件。

02数据统计与分析软件

SPSSStatistica、Eviews、

Matlab、Stata、SAS、R、Python

(图源:网络)

目前,Python是一款最热、功能齐全的软件了,强烈推荐!特别是对编程语言有一定基础的同学更得心应手。不过,SPSS Statistica、Eviews、Matlab、Stata、SAS、R、Python这几款软件也是各有特色的!

对于编程知识薄弱的同学而言,只需要基础统计学知识,就可以操作SPSS。SPSS具有非常强的统计分析功能,如相关分析、回归分析、聚类分析、生存分析等;适合于为计量分析做事前处理,如多元变量降维,数据收集、整合、假设检验等等工作。在回归分析方面,spss能力相对于其他软件而言,不够全面和方便。在此,向大家推荐SPSS 22以上版本。

Eviews是专门为大型机构开发的、用以处理时间序列数据的时间序列软件包的新版本。

Matlab主要用于算法开发、数据可视化、数据分析以及数值计算的高级技术计算语言和交互式环境,它具有友好的用户界面及接近数学表达式的自然化语言,使学者易于学习和掌握;具有完备的图形处理功能,实现计算结果和编程的可视化。但是,Matlab的速度有些慢。

SAS提供了从基本统计数的计算到各种试验设计的方差分析,相关回归分析以及多变数分析的多种统计分析过程,几乎囊括了所有最新分析方法,其分析技术先进,可靠;使用简便,操作灵活;其编程语句简洁,短小,通常只需很小的几句语句即可完成一些复杂的运算,得到满意的结果。

Stata其统计分析能力超过了SPSS,在许多方面也超过了SAS,由于Stata在分析时是将数据全部读入内存,在计算全部完成后才和磁盘交换数据,因此计算速度极快。

一般来说, SAS的运算速度要比SPSS至少快一个数量级,而Stata的某些模块和执行同样功能的SAS模块比,其速度又比SAS快将近一个数量级!

R语言属于GNU系统的一个自由、免费、源代码开放的软件,它是一个用于统计计算和统计制图的优秀工具,制图具有印刷的素质,也可加入数学符号;具有一套源自S语言,完善、简单、有效的编程语言(包括条件、循环、自定义函数、输入输出功能)。

Python为什么如此热门,除了有很强的数据统计与分析的功能,还具有Web 和 Internet开发,网络爬虫等功能。

首先,众多开源的科学计算库都提供了Python的调用接口;用户可以在任何计算机上免费安装Python及其绝大多数扩展库。

其次,与Matlab相比,Python是一门更易学、更严谨的程序设计语言。它能让用户编写出更易读、易维护的代码。

最后,Python有着丰富的扩展库,比如scrapy 爬虫框架、sklearn 机器学习、tensorflow 深度学习,可以轻易完成各种高级任务,开发者可以用Python实现完整应用程序所需的各种功能。

03云笔记

为知笔记、有道云笔记

(图源:网络)

云笔记方便你随时收录与整理文件与网页内容;配合思维导图软件使用,效果更好。为知笔记、有道云笔记通常具有这些优点:

分类整理笔记,高效管理个人知识,快速搜索,分类查找,安全备份云端笔记,存储永不丢失的珍贵资料。

文件同步自动完成——自动同步,无需拷贝下载;支持图片及文档类附件,无限增长的大存储空间。

随时随地记录一切趣事和想法:轻松与电脑双向同步。

精彩网页一键保存——一键保存网页中精彩图文,再也不会遗漏。

手写输入——用手指直接在屏幕上输入,保留手写原笔迹;

涂鸦——轻松、有趣的随手涂鸦,绘制您所想。

04思维导图

Mind Manager、X Mind、

MindMaster、Mind line

(图源:网络)

无论是学习还是工作中,比如写一篇论文、做一次演讲,我们经常需要整理自己的思路,那么思维导图软件是帮助我们理清思路、头脑风暴、抓住灵感最好的工具了;思维导图在搭建知识构架方面也是非常有用的。

Mind Manager是行业中最专业、逼格最高的,但是目前网上你几乎找不到免费版本;X Mind则是免费的,绝对够用;国产的亿图思维导图软件MindMaster也可以也免费。

Mind Manager、X Mind、MindMaster、Mind line这几款的功能很接近,特别推荐X Mind,X Mind 提供各种结构图,比如鱼骨图、矩阵图、时间轴、组织结构图等来帮你更好地理清复杂的想法和事项。这些多种视觉化的思维呈现方式让你能进行深度的对比分析,更直观地进行里程碑的记录和事项的安排。

05文献阅读器

PDF、超星阅读器、CAJ阅读器

有人喜欢Adobe Acrobat Reader,有人采用福昕pdf阅读器,但注意的是做科研的,当然要用专业版本的。

其中,Adobe AcrobatReader要专业版本,福昕要福昕pdf高级编辑器,这些版本的软件功能才会全面,解决pdf的常见需求,比如标记功能、pdf页面管理功能(把图片、word、excel等文件自由地组合到原有pdf文件中去)。

此外,学校往往会购买超星和知网数据库,而超星的电子书籍需要下载超星阅读器才可以看,知网的部分文献,尤其是硕博士论文,需要用官方的CAJ阅读器查看。

06文献管理器

NoteExpress、Mendeley、

E-study、Endnote

NoteExpress是国内专业的文献检索与管理系统,其核心功能是帮助读者高效利用文献,收集并管理得到的文献元数据和全文,帮助科研工作者提高工作效率,此款是比较推荐的!

Mendeley是一款免费的文献管理软件,有一键抓取网页上的文本添加到个人library中的功能,安装插件后还可以编辑文本。

E-study是中国知网的一个附属功能软件,使用方便,能同步下载知网上的论文。

Endnote是汤森路透的老牌文献管理软件,目前最新版是Endnote X9.2,Endnote的文献去重复功能比较突出,但有时候中文支持也不太好。

07科研作图软件

Origin、SigmaPlot、PS、Matlab、R

Origin是国际出版界公认的标准数据处理与科学绘图软件,是一款定位于基础和专业之间的作图软件。它的界面简单,操作也容易入门和掌握。但是,相比于Excel作图,Origin又为我们提供了非常多样的数据图表制作样式以及自定义编辑。

SigmaPlot的功能与Origin非常类似,但是在操作的易用性上会更好,某些样式的图导出后比Origin效果要好,可以与Origin互补。

Adobe photoshop(PS)这个很多时候用来组图,添加点标志,其应用广泛,业余时可以学习ps教程。

此外,Matlab、R也有很强大的作图功能,通过编程实现。比如R语言中也可以实现气泡图、箱线图、专业曲线图的绘制。

08流程图

Visio、ProcessOn

(图源:网络)

在一些论文里面,需要画流程图或者技术路线图,图形能直观体现论文框架或者某个思路,虽然Word里面可制作简单的流程图,但是没有专门的流程图制作软件方便,而且Visio等里面更多的多种功能。

Office Visio 是office软件系列中的负责绘制流程图和示意图的软件,是一款对复杂信息、系统和流程进行可视化处理、分析和交流的软件;具有专业外观的 Office Visio 图表。

ProcessOn是一个在线作图工具的聚合平台,它可以在线画流程图、思维导图、UI原型图、UML、网络拓扑图、组织结构图等等。

09翻译工具

google翻译、CNKI翻译助手、有道翻译

翻译工具的功能基本差不多,其中,CNKI翻译助手中呈现出的例句与词汇均出于学术期刊,而且大多可以追索到对应文献原文;可以帮助搜索到一些专业术语,了解常规表达与用法,顺带着还可以看看国内外相关领域的文献。

小伙伴们对财会证书有备考需求的话,可以关注抖音号!抖主不定时上传CPA方向班老师们的课程,供大家在休闲的时候学习观看!

扫描上方二维码,添加助教老师微信!领取学习礼包!添加时备注:专业+姓名!想要了解注会的报考条件、考试科目、就业方向、学习方法等,记得跟教务老师申请咨询注会的时间哦!

20款适用于网络安全专家的免费取证调查工具

网站优化 • 优采云 发表了文章 • 0 个评论 • 160 次浏览 • 2022-04-30 06:10

一、Autopsy

()

Autopsy是一个基于 GUI 的开源数字取证程序,可有效分析硬盘驱动器和智能手机。全球数以千计的用户使用 Autospy 来调查计算机上发生的事情。

它被公司审查员、军队调查广泛使用,其中一些功能也是如此。

它可以以 HTML、XLS 文件格式生成的大量报告。

二、Encrypted Disk Detector

()

Encrypted Disk Detector有助于检查加密的物理驱动器。它支持 TrueCrypt、PGP、BitLocker、Safeboot 加密卷。

三、Wireshark

()

Wireshark是一种网络捕获和分析工具,用于查看网络中发生的情况。Wireshark 可以方便地调查与网络相关的事件。

四、Magnet RAM capture

()

您可以使用Magnet RAM capture来捕获计算机的物理内存并分析内存中的伪影。

它支持Windows操作系统。

五、Network Miner

()

适用于 Windows、Linux 和 MAC OS X 的有趣网络取证分析器,可通过数据包嗅探或 PCAP 文件检测操作系统、主机名、会话和开放端口。Network Miner在直观的用户界面中提供提取的工件。

六、NMAP

()

Nmap(“网络映射器”)是一个免费和开源的用于网络发现和安全审计的实用程序。许多系统和网络管理员还发现它对网络清单、管理服务升级计划以及监控主机或服务正常运行时间等任务很有用。Nmap 以新颖的方式使用原始 IP 数据包来确定网络上可用的主机、这些主机提供的服务(应用程序名称和版本)、它们运行的操作系统(和操作系统版本)、数据包过滤器/防火墙的类型正在使用中,以及其他数十种特性。它旨在快速扫描大型网络,但对单个主机也能正常工作。Nmap 在所有主要的计算机操作系统上运行,官方二进制包可用于 Linux、Windows 和 Mac OS X。除了经典的命令行 Nmap 可执行文件,Zenmap),一个灵活的数据传输、重定向和调试工具(Ncat),一个用于比较扫描结果的实用程序(Ndiff),以及一个数据包生成和响应分析工具(Nping)。

七、RAM Capturer

()

Belkasoft 的 RAM Capturer是一个免费工具,用于从计算机的易失性内存中转储数据。它与 Windows 操作系统兼容。内存转储可能包含加密卷的密码和网络邮件和社交网络服务的登录凭据。

八、Forensic Investigator

()

如果您使用的是 Splunk,那么Forensic Investigator将是一个方便的工具。这是一个 Splunk 应用程序,结合了许多工具。

九、FAW

()

FAW(Forensics Acquisition of Websites)是获取网页进行取证调查,具有以下特点。

十、HashMyFiles

()

HashMyFiles将帮助您计算 MD5 和 SHA1 哈希值。它适用于几乎所有最新的 Windows 操作系统。

十一、Response

()

Response是一个 Windows 应用程序,用于收集事件响应和安全参与的系统信息。您可以在 CRConvert 的帮助下以 XML、CSV、TSV 或 HTML 格式查看结果。它运行在 32 位或 64 位以上的 Windows XP 上。

Crowd Strike 还有其他一些有用的调查工具。

十二、NFI Defraser

()

Defraser取证工具可以帮助您检测数据流中的全部和部分多媒体文件。

十三、ExifTool

()

ExifTool可帮助您读取、写入和编辑多种文件类型的元信息。它可以读取 EXIF、GPS、IPTC、XMP、JFIF、GeoTIFF、Photoshop IRB、FlashPix 等。

十四、Toolsley

()

Toolsley获得了十多个有用的工具进行调查。

十五、SIFT

(#overview)

SIFT(SANS 调查取证工具包)工作站作为 Ubuntu 14.04 免费提供。SIFT 是您需要的一套取证工具,也是最受欢迎的开源情报平台之一。

十六、Dumpzilla

()

从 Firefox、Iceweasel 和 Seamonkey 浏览器中提取所有令人兴奋的信息,以便使用Dumpzilla进行分析。

十七、ForensicUserInfo

()

使用ForensicUserInfo提取以下信息。

十八、KaliLinux

()

Kali Linux是最流行的安全和渗透测试操作系统之一,但它也具有取证能力。有超过 100 种工具,所以我相信您会找到适合您需要的一种。

十九、PALADIN

()

PALADIN取证套件——世界上最著名的 Linux 取证套件是基于 Ubuntu 的修改版 Linux 发行版,提供 32 位和 64 位版本。

PALADIN拥有29 个类别下的 100 多种工具,几乎可以满足您调查事件所需的一切。Autospy 包含在最新版本 - Paladin 6 中。

二十、The Sleuth Kit

()

Sleuth Kit是一组命令行工具,用于调查和分析卷和文件系统以查找证据。 查看全部

20款适用于网络安全专家的免费取证调查工具

一、Autopsy

()

Autopsy是一个基于 GUI 的开源数字取证程序,可有效分析硬盘驱动器和智能手机。全球数以千计的用户使用 Autospy 来调查计算机上发生的事情。

它被公司审查员、军队调查广泛使用,其中一些功能也是如此。

它可以以 HTML、XLS 文件格式生成的大量报告。

二、Encrypted Disk Detector

()

Encrypted Disk Detector有助于检查加密的物理驱动器。它支持 TrueCrypt、PGP、BitLocker、Safeboot 加密卷。

三、Wireshark

()

Wireshark是一种网络捕获和分析工具,用于查看网络中发生的情况。Wireshark 可以方便地调查与网络相关的事件。

四、Magnet RAM capture

()

您可以使用Magnet RAM capture来捕获计算机的物理内存并分析内存中的伪影。

它支持Windows操作系统。

五、Network Miner

()

适用于 Windows、Linux 和 MAC OS X 的有趣网络取证分析器,可通过数据包嗅探或 PCAP 文件检测操作系统、主机名、会话和开放端口。Network Miner在直观的用户界面中提供提取的工件。

六、NMAP

()

Nmap(“网络映射器”)是一个免费和开源的用于网络发现和安全审计的实用程序。许多系统和网络管理员还发现它对网络清单、管理服务升级计划以及监控主机或服务正常运行时间等任务很有用。Nmap 以新颖的方式使用原始 IP 数据包来确定网络上可用的主机、这些主机提供的服务(应用程序名称和版本)、它们运行的操作系统(和操作系统版本)、数据包过滤器/防火墙的类型正在使用中,以及其他数十种特性。它旨在快速扫描大型网络,但对单个主机也能正常工作。Nmap 在所有主要的计算机操作系统上运行,官方二进制包可用于 Linux、Windows 和 Mac OS X。除了经典的命令行 Nmap 可执行文件,Zenmap),一个灵活的数据传输、重定向和调试工具(Ncat),一个用于比较扫描结果的实用程序(Ndiff),以及一个数据包生成和响应分析工具(Nping)。

七、RAM Capturer

()

Belkasoft 的 RAM Capturer是一个免费工具,用于从计算机的易失性内存中转储数据。它与 Windows 操作系统兼容。内存转储可能包含加密卷的密码和网络邮件和社交网络服务的登录凭据。

八、Forensic Investigator

()

如果您使用的是 Splunk,那么Forensic Investigator将是一个方便的工具。这是一个 Splunk 应用程序,结合了许多工具。

九、FAW

()

FAW(Forensics Acquisition of Websites)是获取网页进行取证调查,具有以下特点。

十、HashMyFiles

()

HashMyFiles将帮助您计算 MD5 和 SHA1 哈希值。它适用于几乎所有最新的 Windows 操作系统。

十一、Response

()

Response是一个 Windows 应用程序,用于收集事件响应和安全参与的系统信息。您可以在 CRConvert 的帮助下以 XML、CSV、TSV 或 HTML 格式查看结果。它运行在 32 位或 64 位以上的 Windows XP 上。

Crowd Strike 还有其他一些有用的调查工具。

十二、NFI Defraser

()

Defraser取证工具可以帮助您检测数据流中的全部和部分多媒体文件。

十三、ExifTool

()

ExifTool可帮助您读取、写入和编辑多种文件类型的元信息。它可以读取 EXIF、GPS、IPTC、XMP、JFIF、GeoTIFF、Photoshop IRB、FlashPix 等。

十四、Toolsley

()

Toolsley获得了十多个有用的工具进行调查。

十五、SIFT

(#overview)

SIFT(SANS 调查取证工具包)工作站作为 Ubuntu 14.04 免费提供。SIFT 是您需要的一套取证工具,也是最受欢迎的开源情报平台之一。

十六、Dumpzilla

()

从 Firefox、Iceweasel 和 Seamonkey 浏览器中提取所有令人兴奋的信息,以便使用Dumpzilla进行分析。

十七、ForensicUserInfo

()

使用ForensicUserInfo提取以下信息。

十八、KaliLinux

()

Kali Linux是最流行的安全和渗透测试操作系统之一,但它也具有取证能力。有超过 100 种工具,所以我相信您会找到适合您需要的一种。

十九、PALADIN

()

PALADIN取证套件——世界上最著名的 Linux 取证套件是基于 Ubuntu 的修改版 Linux 发行版,提供 32 位和 64 位版本。

PALADIN拥有29 个类别下的 100 多种工具,几乎可以满足您调查事件所需的一切。Autospy 包含在最新版本 - Paladin 6 中。

二十、The Sleuth Kit

()

Sleuth Kit是一组命令行工具,用于调查和分析卷和文件系统以查找证据。

网页抓取技术,firebug,,代码查看器安装正式版

网站优化 • 优采云 发表了文章 • 0 个评论 • 59 次浏览 • 2022-04-29 23:00

网页抓取工具有很多,

1)网页一键抓取-fireshot

2)网页一键爬取-urllib2

3)爬虫主要做ip抓取,一般都会带cookie最好将cookie设置好。具体方法我在另一个问题答案中已经有说到:网页抓取技术,

firebug,appium,代码查看器,正则表达式,下面2个也可以,不过要安装正式版(大家搜索okhttp,这个是okhttp2的api封装,带给你android的api以及做移动端的优化)://android学习中的重要pieholic//当我们在请求一个你自己写的接口时候需要查看请求的参数,最常用的方法是下面2个:for(jsonobjectjsonobject:jsonobject){if(stringtoken==jsonobject。

tostring()。equals("1")){return;}try{this。obj[this。token]=jsonobject。getjsonobject(jsonobject。class,jsonobject。string())。getjsonobjectstring();}catch(throwablee){thrownewthrowable("请求string时候使用jsonobject");}}//koajs/http。js文件://。

curl1.和firebug一样都可以抓取图片链接firebug抓取图片;代码可以去github上找,

geekpie/okhttp:buildthewebexpress,functionally。geekpie/urllib2:apythonurlfieldlibraryforlibrarybuilding,theyshouldhaveasimpleindexofjsonfieldswithheadersandnotneededtoimportimages。 查看全部

网页抓取技术,firebug,,代码查看器安装正式版

网页抓取工具有很多,

1)网页一键抓取-fireshot

2)网页一键爬取-urllib2

3)爬虫主要做ip抓取,一般都会带cookie最好将cookie设置好。具体方法我在另一个问题答案中已经有说到:网页抓取技术,

firebug,appium,代码查看器,正则表达式,下面2个也可以,不过要安装正式版(大家搜索okhttp,这个是okhttp2的api封装,带给你android的api以及做移动端的优化)://android学习中的重要pieholic//当我们在请求一个你自己写的接口时候需要查看请求的参数,最常用的方法是下面2个:for(jsonobjectjsonobject:jsonobject){if(stringtoken==jsonobject。

tostring()。equals("1")){return;}try{this。obj[this。token]=jsonobject。getjsonobject(jsonobject。class,jsonobject。string())。getjsonobjectstring();}catch(throwablee){thrownewthrowable("请求string时候使用jsonobject");}}//koajs/http。js文件://。

curl1.和firebug一样都可以抓取图片链接firebug抓取图片;代码可以去github上找,

geekpie/okhttp:buildthewebexpress,functionally。geekpie/urllib2:apythonurlfieldlibraryforlibrarybuilding,theyshouldhaveasimpleindexofjsonfieldswithheadersandnotneededtoimportimages。

网页抓取工具(优采云采集器网址:集搜客没有内容采集规则解析(图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 102 次浏览 • 2022-04-19 07:26

优采云采集器

网址:

优采云采集器 是一个 13 岁的 采集 工具。它不仅可以做爬虫,还可以做数据清洗、分析、挖掘和可视化。数据源适用于绝大多数网页,通过采集规则可以抓取网页上可以看到的内容。

优采云

网址:

优采云 也是一个知名的采集 工具,它有两个版本,一个免费的采集 模板和一个云采集(付费)。

免费的采集模板其实就是内容采集规则,包括电商、生活服务、社交媒体和论坛网站都可以是采集,使用起来很方便。当然你也可以自定义任务。

那么什么是云采集?也就是配置好采集任务后,就可以将采集的任务交给优采云的云端。优采云一共有5000台服务器,通过云端多节点并发采集,采集速度比本地采集快很多。另外,可以自动切换多个IP,避免IP阻塞影响采集。

在很多情况下,自动IP切换和云采集是自动化采集的关键。

吉苏克

该工具具有完全可视化操作,无需编程。整个采集过程也是所见即所得,抓拍结果信息、错误信息等都在软件中体现出来。与优采云相比,Jisouke没有进程的概念。用户只需要关注抓取哪些数据,流程细节完全由吉索客处理。

即搜客的缺点是不具备云采集的功能,所有爬虫都运行在用户自己的电脑上。

更新时间:2019-12-31 查看全部

网页抓取工具(优采云采集器网址:集搜客没有内容采集规则解析(图))

优采云采集器

网址:

优采云采集器 是一个 13 岁的 采集 工具。它不仅可以做爬虫,还可以做数据清洗、分析、挖掘和可视化。数据源适用于绝大多数网页,通过采集规则可以抓取网页上可以看到的内容。

优采云

网址:

优采云 也是一个知名的采集 工具,它有两个版本,一个免费的采集 模板和一个云采集(付费)。

免费的采集模板其实就是内容采集规则,包括电商、生活服务、社交媒体和论坛网站都可以是采集,使用起来很方便。当然你也可以自定义任务。

那么什么是云采集?也就是配置好采集任务后,就可以将采集的任务交给优采云的云端。优采云一共有5000台服务器,通过云端多节点并发采集,采集速度比本地采集快很多。另外,可以自动切换多个IP,避免IP阻塞影响采集。

在很多情况下,自动IP切换和云采集是自动化采集的关键。

吉苏克

该工具具有完全可视化操作,无需编程。整个采集过程也是所见即所得,抓拍结果信息、错误信息等都在软件中体现出来。与优采云相比,Jisouke没有进程的概念。用户只需要关注抓取哪些数据,流程细节完全由吉索客处理。

即搜客的缺点是不具备云采集的功能,所有爬虫都运行在用户自己的电脑上。

更新时间:2019-12-31

网页抓取工具(这里介绍2个不错的爬虫软件—Excel和优采云)

网站优化 • 优采云 发表了文章 • 0 个评论 • 233 次浏览 • 2022-04-16 11:28

这里有两个不错的爬虫软件——Excel 和 优采云。对于常规的静态网页,您可以使用 Excel 对其进行爬网。对于稍微复杂一点的网页,可以使用优采云来爬取。下面先简单介绍一下这两款软件,主要内容如下:

Excel

大多数人都应该使用 Excel。除了日常的数据统计处理,还可以爬取网页数据。让我简单介绍一下爬取过程。主要步骤如下。这里以爬取 PM2.5 数据为例:

1.首先新建一个Excel文件并打开,点击菜单栏中的“数据”->“来自网站”,如下:

2.接下来在弹出的“新建Web查询”对话框中输入需要爬取的URL,点击“Go”,就会加载我们需要爬取的网页,如下:

3.然后,点击右下角的“导入”按钮,选择需要存储数据的工作表或者新建一个工作表,点击“确定”按钮,数据就会自动导入。成功导入的数据如下:

4.这里,如果需要定时刷新数据,可以点击菜单栏中的“属性”,在弹出的对话框中设置刷新频率,定时刷新数据,如下:

优采云

这是一个专门用于采集数据的爬虫软件。它易于学习且易于掌握。您只需要在页面上设置要爬取的元素,即可自动爬取数据,并可保存为Excel或导出到数据库。下面我就简单介绍一下这款软件的安装和使用:

1.下载安装优采云,这个可以直接从官网下载,如下,点击下载安装即可:

2.安装完成后,打开软件,在主界面点击“自定义采集”,如下:

3.然后在任务页面输入要爬取的网页地址,如下,这里以爬取公众评论数据为例:

4.点击“保存网址”自动打开网页,如下:

5.接下来我们可以直接选择需要爬取的标签数据,如下,按照操作提示一步一步往下走,很简单:

6.设置完成后点击“本地启动采集”自动开始爬取数据。爬取成功后的数据如下,也就是我们刚刚设置的标签数据:

7.这里点击“导出数据”,将爬取的数据导出为你需要的格式,如下,可以是Excel、CSV、数据库等:

至此,我们已经完成了使用Excel和优采云抓取网页数据。总的来说,这两个软件使用起来非常简单。只要熟悉相关操作,就能很快掌握。当然你也可以使用其他爬虫软件,比如优采云等,基本功能和优采云类似,网上也有相关资料和教程。如果你有兴趣,你可以搜索它。希望以上分享的内容对您有所帮助。也欢迎评论和留言。 查看全部

网页抓取工具(这里介绍2个不错的爬虫软件—Excel和优采云)

这里有两个不错的爬虫软件——Excel 和 优采云。对于常规的静态网页,您可以使用 Excel 对其进行爬网。对于稍微复杂一点的网页,可以使用优采云来爬取。下面先简单介绍一下这两款软件,主要内容如下:

Excel

大多数人都应该使用 Excel。除了日常的数据统计处理,还可以爬取网页数据。让我简单介绍一下爬取过程。主要步骤如下。这里以爬取 PM2.5 数据为例:

1.首先新建一个Excel文件并打开,点击菜单栏中的“数据”->“来自网站”,如下:

2.接下来在弹出的“新建Web查询”对话框中输入需要爬取的URL,点击“Go”,就会加载我们需要爬取的网页,如下:

3.然后,点击右下角的“导入”按钮,选择需要存储数据的工作表或者新建一个工作表,点击“确定”按钮,数据就会自动导入。成功导入的数据如下:

4.这里,如果需要定时刷新数据,可以点击菜单栏中的“属性”,在弹出的对话框中设置刷新频率,定时刷新数据,如下:

优采云

这是一个专门用于采集数据的爬虫软件。它易于学习且易于掌握。您只需要在页面上设置要爬取的元素,即可自动爬取数据,并可保存为Excel或导出到数据库。下面我就简单介绍一下这款软件的安装和使用:

1.下载安装优采云,这个可以直接从官网下载,如下,点击下载安装即可:

2.安装完成后,打开软件,在主界面点击“自定义采集”,如下:

3.然后在任务页面输入要爬取的网页地址,如下,这里以爬取公众评论数据为例:

4.点击“保存网址”自动打开网页,如下:

5.接下来我们可以直接选择需要爬取的标签数据,如下,按照操作提示一步一步往下走,很简单:

6.设置完成后点击“本地启动采集”自动开始爬取数据。爬取成功后的数据如下,也就是我们刚刚设置的标签数据:

7.这里点击“导出数据”,将爬取的数据导出为你需要的格式,如下,可以是Excel、CSV、数据库等:

至此,我们已经完成了使用Excel和优采云抓取网页数据。总的来说,这两个软件使用起来非常简单。只要熟悉相关操作,就能很快掌握。当然你也可以使用其他爬虫软件,比如优采云等,基本功能和优采云类似,网上也有相关资料和教程。如果你有兴趣,你可以搜索它。希望以上分享的内容对您有所帮助。也欢迎评论和留言。

网页抓取工具(手把手教一个人使用bs4写一个简单抓取工具)

网站优化 • 优采云 发表了文章 • 0 个评论 • 69 次浏览 • 2022-04-13 00:06

网页抓取工具有很多种,最常见的就是用bs4语言和html5语言。首先看最低端的bs4吧,python或者java。要求你学习了一门或两门网页编程语言,诸如html、css、xml、tags、php等等。如果说有一个网页编程语言,一个在线工具可以快速提取网页的详细信息,那么就一定是bs4,当然可以是bs4其他语言,只是这种做法可以节省很多学习成本而已。

效率上来说都差不多,因为html5的dom结构就非常复杂,原生xml+json已经非常落后了。而bs4的xml结构可以直接用自己的语言实现。手把手教一个人使用bs4写一个简单抓取工具的话,知乎上已经有相关的回答。可以自己去找:python爬虫工具使用教程。但是很多人都说360在做广告,虽然百度也是广告,但360去打广告还要查你「广告过滤」,而且它那样做也是因为网络开放没必要抓。

而html5没有webgl的话自己写不了,所以最好学习下bs4语言。如果会bs4语言,一个语言用来写chrome浏览器上的webgl网页,然后用自己的语言实现就可以了。python的话,就是bs4+webgl,就解决问题。

以w3cbs4为例,关于freebrowser抓取相关的工具有:、freebrowser在线抓取工具以及html5的抓取工具。他们的开发者文档中对网页爬取的教程、方法都有介绍。freebrowser在线抓取工具是一个轻量级开源爬虫爬取服务,可以免费试用以及租用服务。它拥有完善的抓取方案,包括完整的爬取库,支持http,https协议,包括user-agent,压缩和分块上传,并且可以同时采用多个协议支持包括p2p,webrtc和文件上传。

freebrowser抓取工具可以方便的爬取到mozilla,whatwg,javascript和其他各种传统语言。可以看下freebrowser工具,开源代码:,html5抓取方面,有需要的可以自己学习。html5抓取教程,见这篇文章。 查看全部

网页抓取工具(手把手教一个人使用bs4写一个简单抓取工具)

网页抓取工具有很多种,最常见的就是用bs4语言和html5语言。首先看最低端的bs4吧,python或者java。要求你学习了一门或两门网页编程语言,诸如html、css、xml、tags、php等等。如果说有一个网页编程语言,一个在线工具可以快速提取网页的详细信息,那么就一定是bs4,当然可以是bs4其他语言,只是这种做法可以节省很多学习成本而已。

效率上来说都差不多,因为html5的dom结构就非常复杂,原生xml+json已经非常落后了。而bs4的xml结构可以直接用自己的语言实现。手把手教一个人使用bs4写一个简单抓取工具的话,知乎上已经有相关的回答。可以自己去找:python爬虫工具使用教程。但是很多人都说360在做广告,虽然百度也是广告,但360去打广告还要查你「广告过滤」,而且它那样做也是因为网络开放没必要抓。

而html5没有webgl的话自己写不了,所以最好学习下bs4语言。如果会bs4语言,一个语言用来写chrome浏览器上的webgl网页,然后用自己的语言实现就可以了。python的话,就是bs4+webgl,就解决问题。

以w3cbs4为例,关于freebrowser抓取相关的工具有:、freebrowser在线抓取工具以及html5的抓取工具。他们的开发者文档中对网页爬取的教程、方法都有介绍。freebrowser在线抓取工具是一个轻量级开源爬虫爬取服务,可以免费试用以及租用服务。它拥有完善的抓取方案,包括完整的爬取库,支持http,https协议,包括user-agent,压缩和分块上传,并且可以同时采用多个协议支持包括p2p,webrtc和文件上传。

freebrowser抓取工具可以方便的爬取到mozilla,whatwg,javascript和其他各种传统语言。可以看下freebrowser工具,开源代码:,html5抓取方面,有需要的可以自己学习。html5抓取教程,见这篇文章。

网页抓取工具(网页抓取工具推荐百度、搜狗的动态页面都有哪些)

网站优化 • 优采云 发表了文章 • 0 个评论 • 60 次浏览 • 2022-04-05 19:03

网页抓取工具推荐,

百度、搜狗的动态页面都有抓取,不同网站下载的数据格式不一样,

谢邀。根据前面的回答,做一些补充。两方面。一方面一个页面一个网站搜集一下静态资源。另一方面,通过爬虫抓取某些网站的页面。动态页面可以分析出来是xml也可以是json,可以针对性选择,先从单页面下手,从中看一下网站是否有数据被爬取。知道动态源地址后,就可以和网站的静态存储结合起来,非静态抓取的动态资源多可以用两层存储结构,一层是redis一层是mysql,常用的是redis。

谢邀。比较古老的解决方案可以参考我做过的一个网站中文词云生成.cms新型解决方案可以参考我提供的一些产品在我的想法交流区,有很多资源如产品文档,技术交流,产品等等,有需要可以加我微信。

大约靠个google什么的吧...

谢邀,有两个方法。第一个是模拟浏览器在另一个网站上访问,这样就可以获取到一个真实的浏览器页面然后用反爬手段来抓取。第二个方法是模拟浏览器在翻页的时候,按逆序ctrl+c复制页面数据,然后下载到本地,然后用的反爬手段来抓取。如果没有真实的浏览器,那么就需要一些简单的网页抓取技术。至于效率,有些抓取代理对于你需要的网站会很有帮助,比如安飞士agency。要抓取的页面比较多,用模拟浏览器会比较耗时。 查看全部

网页抓取工具(网页抓取工具推荐百度、搜狗的动态页面都有哪些)

网页抓取工具推荐,

百度、搜狗的动态页面都有抓取,不同网站下载的数据格式不一样,

谢邀。根据前面的回答,做一些补充。两方面。一方面一个页面一个网站搜集一下静态资源。另一方面,通过爬虫抓取某些网站的页面。动态页面可以分析出来是xml也可以是json,可以针对性选择,先从单页面下手,从中看一下网站是否有数据被爬取。知道动态源地址后,就可以和网站的静态存储结合起来,非静态抓取的动态资源多可以用两层存储结构,一层是redis一层是mysql,常用的是redis。

谢邀。比较古老的解决方案可以参考我做过的一个网站中文词云生成.cms新型解决方案可以参考我提供的一些产品在我的想法交流区,有很多资源如产品文档,技术交流,产品等等,有需要可以加我微信。

大约靠个google什么的吧...

谢邀,有两个方法。第一个是模拟浏览器在另一个网站上访问,这样就可以获取到一个真实的浏览器页面然后用反爬手段来抓取。第二个方法是模拟浏览器在翻页的时候,按逆序ctrl+c复制页面数据,然后下载到本地,然后用的反爬手段来抓取。如果没有真实的浏览器,那么就需要一些简单的网页抓取技术。至于效率,有些抓取代理对于你需要的网站会很有帮助,比如安飞士agency。要抓取的页面比较多,用模拟浏览器会比较耗时。

网页抓取工具(初识scraper打开WebScraper的图标(一)_光明网(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 65 次浏览 • 2022-04-02 14:13

Web Scraper 是一款面向普通用户(无需专业 IT 技能)的免费爬虫工具,通过鼠标和简单的配置即可轻松获取您想要的数据。例如知乎答案列表、微博热门、微博评论、电商网站产品信息、博客文章列表等。在线安装方式在线安装需要开通FQ的网络,您可以访问 Chrome App Store 1、 在线访问 web Scraper 插件,然后单击“添加到 CHROME”。

2、然后在弹出的窗口中点击“添加扩展”

3、安装完成后,在顶部工具栏中显示 Web Scraper 图标。

本地安装

1、打开Chrome,在地址栏输入chrome://extensions/,进入扩展管理界面,然后下载下载的扩展Web-Scraper_v0.3.7. crx拖放到这个页面,点击“添加到扩展”完成安装。如图所示:

2、安装完成后在顶部工具栏中显示 Web Scraper 图标。

了解网络爬虫

打开网络抓取工具

开发者可以路过,回头看看

windows系统下可以使用快捷键F12,部分型号的笔记本需要按Fn+F12;

Mac系统下,可以使用快捷键command+option+i;

也可以直接在Chrome界面操作,点击设置->更多工具->开发者工具

打开后的效果如下。绿框部分是开发者工具的完整界面,红框部分是Web Scraper区域,也就是我们后面要操作的部分。

注意:如果在浏览器右侧区域打开开发者工具,需要将开发者工具的位置调整到浏览器底部。

原理及功能说明

数据爬取的思路大致可以简单概括如下:

1、通过一个或多个入口地址获取初始数据。比如一个 文章 列表页,或者一个带有某种规则的页面,比如一个带有分页的列表页;

2、根据入口页面的某些信息,如链接指向,进入下一级页面获取必要信息;

3、根据上一关的链接继续进入下一关,获取必要的信息(此步骤可无限循环进行);

原理大致相同。接下来我们正式认识一下Web Scraper这个工具。来吧,打开开发者工具,点击Web Scraper选项卡,看到它分为三个部分:

创建新的sitemap:首先了解sitemap,字面意思是网站map,这里可以理解为一个入口地址,可以理解为它对应一个网站,对应一个需求,假设你想在 知乎 上回答问题,创建一个站点地图,并将问题的地址设置为站点地图的起始 URL,然后点击“创建站点地图”创建站点地图。

站点地图:站点地图的集合,所有创建的站点地图都会显示在这里,您可以在这里输入站点地图来修改和获取数据。

站点地图:进入站点地图,可以进行一系列操作,如下图:

添加新选择器的红框部分是必不可少的步骤。什么是选择器,字面意思:选择器,一个选择器对应网页上的一部分区域,也就是收录我们要采集的数据的部分。

需要说明一下,一个sitemap可以有多个选择器,每个选择器可以收录子选择器,一个选择器可以只对应一个标题,也可以对应整个区域,这个区域可能收录标题、副标题、作者信息、内容等. 和其他信息。

选择器:查看所有选择器。

选择器图:查看当前站点地图的拓扑图,什么是根节点,收录几个选择器,以及选择器下收录的子选择器。

编辑元数据:您可以修改站点地图信息、标题和起始地址。

刮:开始数据刮工作。

将数据导出为 CSV:以 CSV 格式导出捕获的数据。

至此,有一个简单的了解就足够了。只有实践了真知,具体的操作案例才能令人信服。下面举几个例子来说明具体用法。

案例实践

简单试水hao123

由浅入深,先从最简单的例子开始,只是为了进一步了解Web Scraper服务

需求背景:见下文hao123页面红框部分。我们的要求是统计这个区域中所有网站的名字和链接地址,最后生成到Excel中。因为这部分内容足够简单,当然实际的需求可能比这更复杂,而且手动统计这么几条数据的时间也很快。

开始

1、假设我们打开了hao123页面,打开该页面底部的开发者工具,找到Web Scraper标签栏;

2、点击“创建站点地图”;

3、 然后输入站点地图名称和起始网址。名字只是为了方便我们标记,所以命名为hao123(注意不支持中文),起始url是hao123的网址,然后点击create sitemap;

4、Web Scraper 自动定位到这个站点地图后,我们添加一个选择器,点击“添加新选择器”;

5、首先,给这个选择器分配一个id,这只是一个方便识别的名字。我在这里把它命名为热。因为要获取名称和链接,所以将Type设置为Link,这是专门为网页链接准备的。选择链接类型后,会自动提取名称和链接两个属性;

6、之后点击选择,然后我们在网页上移动光标,我们会发现光标的颜色会发生变化,变成绿色,说明是当前选中的区域我们。我们将光标定位到需求中提到的栏目中的一个链接,比如第一条头条新闻,点击这里,这部分会变红,说明已经被选中,我们的目的是选中有多个,所以选中后这个,继续选择第二个,我们会发现这一行的链接都变成了红色,没错,这就是我们想要的效果。然后点击“完成选择!” (数据预览是被选中元素的标识,可以手动修改,元素由类和元素名决定,如:div.p_name a),最后don'

7、最后保存,保存选择器。点击元素预览可以预览选中的区域,点击数据预览可以在浏览器中预览截取的数据。后面文本框中的内容对于懂技术的同学来说是很清楚的。这是xpath。我们可以不用鼠标操作直接写xpath;

完整的操作流程如下:

8、经过上一步,就可以真正导出了。别着急,看看其他操作,Sitemap hao123下的Selector图,可以看到拓扑图,_root是根选择器,创建sitemap会自动有一个_root节点,可以看到它的子选择器,即我们是否创建了热选择器;

9、Scrape 开始抓取数据。

10、在Sitemap hao123下浏览,可以通过浏览器直接查看爬取的最终结果,需要重新;

11、最后使用Export data as CSV,以CSV格式导出,其中hot栏为标题,hot-href栏为链接;

怎么样,马上试试 查看全部

网页抓取工具(初识scraper打开WebScraper的图标(一)_光明网(组图))

Web Scraper 是一款面向普通用户(无需专业 IT 技能)的免费爬虫工具,通过鼠标和简单的配置即可轻松获取您想要的数据。例如知乎答案列表、微博热门、微博评论、电商网站产品信息、博客文章列表等。在线安装方式在线安装需要开通FQ的网络,您可以访问 Chrome App Store 1、 在线访问 web Scraper 插件,然后单击“添加到 CHROME”。

2、然后在弹出的窗口中点击“添加扩展”

3、安装完成后,在顶部工具栏中显示 Web Scraper 图标。

本地安装

1、打开Chrome,在地址栏输入chrome://extensions/,进入扩展管理界面,然后下载下载的扩展Web-Scraper_v0.3.7. crx拖放到这个页面,点击“添加到扩展”完成安装。如图所示:

2、安装完成后在顶部工具栏中显示 Web Scraper 图标。

了解网络爬虫

打开网络抓取工具

开发者可以路过,回头看看

windows系统下可以使用快捷键F12,部分型号的笔记本需要按Fn+F12;

Mac系统下,可以使用快捷键command+option+i;

也可以直接在Chrome界面操作,点击设置->更多工具->开发者工具

打开后的效果如下。绿框部分是开发者工具的完整界面,红框部分是Web Scraper区域,也就是我们后面要操作的部分。

注意:如果在浏览器右侧区域打开开发者工具,需要将开发者工具的位置调整到浏览器底部。

原理及功能说明

数据爬取的思路大致可以简单概括如下:

1、通过一个或多个入口地址获取初始数据。比如一个 文章 列表页,或者一个带有某种规则的页面,比如一个带有分页的列表页;

2、根据入口页面的某些信息,如链接指向,进入下一级页面获取必要信息;

3、根据上一关的链接继续进入下一关,获取必要的信息(此步骤可无限循环进行);

原理大致相同。接下来我们正式认识一下Web Scraper这个工具。来吧,打开开发者工具,点击Web Scraper选项卡,看到它分为三个部分:

创建新的sitemap:首先了解sitemap,字面意思是网站map,这里可以理解为一个入口地址,可以理解为它对应一个网站,对应一个需求,假设你想在 知乎 上回答问题,创建一个站点地图,并将问题的地址设置为站点地图的起始 URL,然后点击“创建站点地图”创建站点地图。

站点地图:站点地图的集合,所有创建的站点地图都会显示在这里,您可以在这里输入站点地图来修改和获取数据。

站点地图:进入站点地图,可以进行一系列操作,如下图:

添加新选择器的红框部分是必不可少的步骤。什么是选择器,字面意思:选择器,一个选择器对应网页上的一部分区域,也就是收录我们要采集的数据的部分。

需要说明一下,一个sitemap可以有多个选择器,每个选择器可以收录子选择器,一个选择器可以只对应一个标题,也可以对应整个区域,这个区域可能收录标题、副标题、作者信息、内容等. 和其他信息。

选择器:查看所有选择器。

选择器图:查看当前站点地图的拓扑图,什么是根节点,收录几个选择器,以及选择器下收录的子选择器。

编辑元数据:您可以修改站点地图信息、标题和起始地址。

刮:开始数据刮工作。

将数据导出为 CSV:以 CSV 格式导出捕获的数据。

至此,有一个简单的了解就足够了。只有实践了真知,具体的操作案例才能令人信服。下面举几个例子来说明具体用法。

案例实践

简单试水hao123

由浅入深,先从最简单的例子开始,只是为了进一步了解Web Scraper服务

需求背景:见下文hao123页面红框部分。我们的要求是统计这个区域中所有网站的名字和链接地址,最后生成到Excel中。因为这部分内容足够简单,当然实际的需求可能比这更复杂,而且手动统计这么几条数据的时间也很快。

开始

1、假设我们打开了hao123页面,打开该页面底部的开发者工具,找到Web Scraper标签栏;

2、点击“创建站点地图”;

3、 然后输入站点地图名称和起始网址。名字只是为了方便我们标记,所以命名为hao123(注意不支持中文),起始url是hao123的网址,然后点击create sitemap;

4、Web Scraper 自动定位到这个站点地图后,我们添加一个选择器,点击“添加新选择器”;

5、首先,给这个选择器分配一个id,这只是一个方便识别的名字。我在这里把它命名为热。因为要获取名称和链接,所以将Type设置为Link,这是专门为网页链接准备的。选择链接类型后,会自动提取名称和链接两个属性;

6、之后点击选择,然后我们在网页上移动光标,我们会发现光标的颜色会发生变化,变成绿色,说明是当前选中的区域我们。我们将光标定位到需求中提到的栏目中的一个链接,比如第一条头条新闻,点击这里,这部分会变红,说明已经被选中,我们的目的是选中有多个,所以选中后这个,继续选择第二个,我们会发现这一行的链接都变成了红色,没错,这就是我们想要的效果。然后点击“完成选择!” (数据预览是被选中元素的标识,可以手动修改,元素由类和元素名决定,如:div.p_name a),最后don'

7、最后保存,保存选择器。点击元素预览可以预览选中的区域,点击数据预览可以在浏览器中预览截取的数据。后面文本框中的内容对于懂技术的同学来说是很清楚的。这是xpath。我们可以不用鼠标操作直接写xpath;

完整的操作流程如下:

8、经过上一步,就可以真正导出了。别着急,看看其他操作,Sitemap hao123下的Selector图,可以看到拓扑图,_root是根选择器,创建sitemap会自动有一个_root节点,可以看到它的子选择器,即我们是否创建了热选择器;

9、Scrape 开始抓取数据。

10、在Sitemap hao123下浏览,可以通过浏览器直接查看爬取的最终结果,需要重新;

11、最后使用Export data as CSV,以CSV格式导出,其中hot栏为标题,hot-href栏为链接;

怎么样,马上试试

网页抓取工具(安卓版的网页抓取工具crawlerpi地址是怎样的??)

网站优化 • 优采云 发表了文章 • 0 个评论 • 67 次浏览 • 2022-03-30 09:00

网页抓取工具crawlerpi地址:,用来找出公交车的路线、时间(公交车应该只有一个方向)等信息android版本可以用一个app或者一个网页server。安卓版的抓取工具rz2的网页是先加载国内cdn服务器的页面。然后才抓取手机。这种方式会比较慢。

给你看一个图,

你说的那个rz2基本没有用,因为1,他抓不到你手机卡里的信息2,他抓不到手机的网站链接然后你会发现虽然他能抓,并不是每次抓都抓到你的目标,或者说抓住了都抓不到,因为抓包程序员有可能会编个程序抓数据包然后交给网站服务器。而rz2只抓你自己手机卡里的,

你可以去用真实信息采集代理,国内rt定位为2.5亿的市场,

本来是找到了,然后发现是明显的机器人网站。建议直接去人肉,比如一只大爷大妈,平时在哪发qq信息之类的。

建议工程狗向互联网公司提出再加一个条件。就是人肉到什么程度?把js做进去一部分在浏览器里了吧。

因为,人家发现的数据也是根据url下载的来着。

关键的问题是,你从那个页面下载的数据,就是正确的数据,你肯定无法逆推网页源代码。

全是中间页。

其实手机网页抓包这方面有很多网站可以研究,搜狗手机浏览器是可以抓包的,推荐, 查看全部

网页抓取工具(安卓版的网页抓取工具crawlerpi地址是怎样的??)

网页抓取工具crawlerpi地址:,用来找出公交车的路线、时间(公交车应该只有一个方向)等信息android版本可以用一个app或者一个网页server。安卓版的抓取工具rz2的网页是先加载国内cdn服务器的页面。然后才抓取手机。这种方式会比较慢。

给你看一个图,

你说的那个rz2基本没有用,因为1,他抓不到你手机卡里的信息2,他抓不到手机的网站链接然后你会发现虽然他能抓,并不是每次抓都抓到你的目标,或者说抓住了都抓不到,因为抓包程序员有可能会编个程序抓数据包然后交给网站服务器。而rz2只抓你自己手机卡里的,

你可以去用真实信息采集代理,国内rt定位为2.5亿的市场,

本来是找到了,然后发现是明显的机器人网站。建议直接去人肉,比如一只大爷大妈,平时在哪发qq信息之类的。

建议工程狗向互联网公司提出再加一个条件。就是人肉到什么程度?把js做进去一部分在浏览器里了吧。

因为,人家发现的数据也是根据url下载的来着。

关键的问题是,你从那个页面下载的数据,就是正确的数据,你肯定无法逆推网页源代码。

全是中间页。

其实手机网页抓包这方面有很多网站可以研究,搜狗手机浏览器是可以抓包的,推荐,

网页抓取工具(网页抓取工具使用方法:搜索"青瓜网页(抓取))

网站优化 • 优采云 发表了文章 • 0 个评论 • 63 次浏览 • 2022-03-25 06:01

网页抓取工具使用方法:搜索"青瓜网页抓取"网站查看他们网站抓取数据的工具,还有详细的工具使用方法,动态页面网站就可以抓取数据即时性。如果遇到什么不明白的,再看下下面的网站。点击这里青瓜网页抓取:。有一种我叫青瓜网页抓取即时性的自动抓取的,还有结果展示,实时看。大家可以自己多多去看下,有什么不明白的可以咨询。

一般楼上网站所说都是首页抓取,本人专业从事抓取技术,首页抓取不难,难点就是内容抓取,如图。这是大站每日活跃用户最多的几个页面。很明显,我们要抓取的有广告区域,

青瓜网页抓取是一款网页抓取小工具,只要通过相关网址,均可抓取相关页面,抓取页面后,可快速上传新页面,通过网页提取,轻松完成网页上的广告位的抓取,通过合并重复页面即可快速提取各类网页,操作流程简单方便。

1、快速抓取页面:在无需编程的前提下,抓取广告区域页面,自动完成新页面抓取(及各类网页上的广告抓取)。

2、更多页面自动抓取:针对不同的主题或网站页面,进行独立抓取。

3、爬虫报表统计:通过对抓取的网页数据进行统计分析,统计收入,统计各类网页流量,统计各类网页数据,甚至可以统计各类网页访问时间。

4、其他:可以抓取网页上的图片、地址栏、文章、公众号文章、banner图等不同网页内容,在需要的页面进行跳转,来完成某些网页地址的抓取。注意:必须输入正确页面地址,否则会报错。(ps:因为我们需要抓取的是整个网页,所以这里的需要抓取的页面需要和实际页面不一样。

5、更多功能:不同网站上的广告抓取、banner抓取,网页重定向抓取、flash抓取、网页抓取报表等。

6、其他:重复抓取无需输入页面地址,无需网页解析,真正无需编程。

二、工具特点:无需开发,轻松抓取网页,适合低端抓取工具。

三、使用说明:无需任何编程基础,手动输入url即可。抓取的时候手动刷新页面即可。只要网页上带有广告,就会报错。网页重定向至多100次后,即可抓取所有网页。

三、软件介绍:青瓜网页抓取支持正则表达式、python

2、python3,无需任何编程基础。专业为网页抓取而生,覆盖多个主流网站,抓取手机网站,同时支持手机app,大小仅1m左右,适合多端抓取,开发简单,直接抓取网页。

四、功能介绍:

1、网页抓取(pc端、app、移动端)

2、网页内容抓取、结构化数据抓取

3、网页代码多文件提取

4、网页缓存实用性:

1、可以直接通过python

2、python

3、matlab2来读取图片,

2、可以爬取联盟二维 查看全部

网页抓取工具(网页抓取工具使用方法:搜索"青瓜网页(抓取))

网页抓取工具使用方法:搜索"青瓜网页抓取"网站查看他们网站抓取数据的工具,还有详细的工具使用方法,动态页面网站就可以抓取数据即时性。如果遇到什么不明白的,再看下下面的网站。点击这里青瓜网页抓取:。有一种我叫青瓜网页抓取即时性的自动抓取的,还有结果展示,实时看。大家可以自己多多去看下,有什么不明白的可以咨询。

一般楼上网站所说都是首页抓取,本人专业从事抓取技术,首页抓取不难,难点就是内容抓取,如图。这是大站每日活跃用户最多的几个页面。很明显,我们要抓取的有广告区域,

青瓜网页抓取是一款网页抓取小工具,只要通过相关网址,均可抓取相关页面,抓取页面后,可快速上传新页面,通过网页提取,轻松完成网页上的广告位的抓取,通过合并重复页面即可快速提取各类网页,操作流程简单方便。

1、快速抓取页面:在无需编程的前提下,抓取广告区域页面,自动完成新页面抓取(及各类网页上的广告抓取)。

2、更多页面自动抓取:针对不同的主题或网站页面,进行独立抓取。

3、爬虫报表统计:通过对抓取的网页数据进行统计分析,统计收入,统计各类网页流量,统计各类网页数据,甚至可以统计各类网页访问时间。

4、其他:可以抓取网页上的图片、地址栏、文章、公众号文章、banner图等不同网页内容,在需要的页面进行跳转,来完成某些网页地址的抓取。注意:必须输入正确页面地址,否则会报错。(ps:因为我们需要抓取的是整个网页,所以这里的需要抓取的页面需要和实际页面不一样。

5、更多功能:不同网站上的广告抓取、banner抓取,网页重定向抓取、flash抓取、网页抓取报表等。

6、其他:重复抓取无需输入页面地址,无需网页解析,真正无需编程。

二、工具特点:无需开发,轻松抓取网页,适合低端抓取工具。

三、使用说明:无需任何编程基础,手动输入url即可。抓取的时候手动刷新页面即可。只要网页上带有广告,就会报错。网页重定向至多100次后,即可抓取所有网页。

三、软件介绍:青瓜网页抓取支持正则表达式、python

2、python3,无需任何编程基础。专业为网页抓取而生,覆盖多个主流网站,抓取手机网站,同时支持手机app,大小仅1m左右,适合多端抓取,开发简单,直接抓取网页。

四、功能介绍:

1、网页抓取(pc端、app、移动端)

2、网页内容抓取、结构化数据抓取

3、网页代码多文件提取

4、网页缓存实用性:

1、可以直接通过python

2、python

3、matlab2来读取图片,

2、可以爬取联盟二维

网页抓取工具(csdn历史发帖抓取工具大多是针对抓取web网页这个任务)

网站优化 • 优采云 发表了文章 • 0 个评论 • 63 次浏览 • 2022-03-09 11:02

网页抓取工具大多是针对抓取web网页这个任务,能够快速抓取web网页内容。方法不同,抓取效率高低不同。试用过三款,不同抓取原理的网页抓取工具,一款总结方法。

一、百度风云搜索框里输入标题、url、关键词,即可自动抓取;利用百度爬虫技术抓取的内容被过滤重复项。

二、csdn历史发帖抓取工具,采用了爬虫技术获取内容,过滤重复内容。但是缺点是抓取速度慢。

三、企业互联网应用中心,利用企业产品链接获取内容,可以到期互联网产品网站查看。

四、第一搜索,利用fiddler抓取内容的方法,前期要配置好fiddler,抓取效率慢。

学个python,

前人总结的方法总比没有的好,大牛的回答都特别精彩,

tineye,谷歌学术api,必应api就这些了,是谷歌学术,

高质量的网站到处都是,

直接抓取googlepublicdomain:variouspublicdomainsweb:scientificandbusinessnewslink: 查看全部

网页抓取工具(csdn历史发帖抓取工具大多是针对抓取web网页这个任务)

网页抓取工具大多是针对抓取web网页这个任务,能够快速抓取web网页内容。方法不同,抓取效率高低不同。试用过三款,不同抓取原理的网页抓取工具,一款总结方法。

一、百度风云搜索框里输入标题、url、关键词,即可自动抓取;利用百度爬虫技术抓取的内容被过滤重复项。

二、csdn历史发帖抓取工具,采用了爬虫技术获取内容,过滤重复内容。但是缺点是抓取速度慢。

三、企业互联网应用中心,利用企业产品链接获取内容,可以到期互联网产品网站查看。

四、第一搜索,利用fiddler抓取内容的方法,前期要配置好fiddler,抓取效率慢。

学个python,

前人总结的方法总比没有的好,大牛的回答都特别精彩,

tineye,谷歌学术api,必应api就这些了,是谷歌学术,

高质量的网站到处都是,

直接抓取googlepublicdomain:variouspublicdomainsweb:scientificandbusinessnewslink:

网页抓取工具(obdl通话、通话记录获取取使用网站获取的费用更低)

网站优化 • 优采云 发表了文章 • 0 个评论 • 92 次浏览 • 2022-03-04 17:22

湖北省网络爬虫obdl

如今,运营商的大数据参差不齐。市场上有多种形式的收购和捕获。原来是:1.通过数据采集软件,通过软件采集网站客户在@>上主动留下的爬取,二是爬虫网站爬取,已经在APP上,第三,通过安装网站中的代码获得,这些通过网站获得> 安装抓取代码,然后抓取访问者的。其缺点如下。一是只能捕获自己的网站访问者,二是只能被php网站使用,三是涉及客户隐私,容易被检测到通过推广。

2.通话和通话记录的获取和使用网站通过手机在互联网上获取信息的人通常素质高、学历高。手机捕捉访客密码,配合市场策略,最大限度地发挥这类信息的成功率。客户占上风。3.从移动端获取通话和通话记录的成本更低,获取的目标客户的第一手信息程度更是天壤之别。网站对这些代码的访问也将成为用户的无形资产。网站进入市场广泛,客户无限,联通、电信、移动通关,打造全国首个移动客户复制系统,客户跟单交易率暴涨!“运营商大数据营销”,您可以从任何网站、APP和手机中直接获取实时访客电话信息。APP下载的用户资料、拨打座机的用户信息、400电话号码,则此操作将侵犯用户隐私。

只要你提交这个站点,运营商就会提取在这个网站上消耗流量的用户。这样就实现了网站的捕获,间接实现了营销。应用抓取是一回事。只要标记了所使用的浏览,就会被提交者获取。比如你是家装师,当你能拿到大型装修办公桌的数据时,浏览过这些网站的人不敢说都需要装修,但大部分还是有心的. 直接获客是比你的广告更直接的获客方式,也能省下不少钱。这种网站捕获的获客方式是一种新的营销方式,用好产品为商家解决客户问题。网站 爬取当前数据采集、爬虫、算子大数据建模、自己添加JS代码网站等,我只详细介绍后两种方式。移动联通运营商大数据建模与数据采集:主要是拦截同行的实时客户。

对访问APP超过一分钟的意向客户进行抓拍,因此运营商的大数据不仅限于自己的网站获取客户,任何网站、APP、400电话、固话你可以抓住并得到它。我们是正规运营商,与运营商有深度合作。运营商采集数据并发送给企业,然后提供专门的大数据营销后台供企业调用。网站同行每天有多少客户访问他们的网站,我们可以实时拦截每天频繁访问网站的客户,同行业400个电话,或公司座机,每天有多少客户打电话咨询,我们可以拦截正在通话的客户或同行,今日头条,

如何采集这个数据。采集 的这些数据如何衡量应用的流量。手机APP应用采集的数据,手机APP其实是通过HTTP协议与之交互的。只要我们分析一下接口地址和参数的含义,就可以像采集普通网站采集App数据。这里有一些可以使用的专业工具。很多APP通过主动采集数据来改进智能元素的模式。用户数越大,数据采集时间越长,对用户需求的分析越精准,未来的发展趋势必然是主动数据采集、数据采集、移动网站 + 手机APP相互结合,多种方式组合获取和处理数据。数据的用途会越来越多,

网站获取访问者代码,比如你在浏览今日头条,我们可以通过你浏览今日头条的那个获取你的,然后你可以给那个人发短信。

但绝大多数仍然是故意的。直接获客是比你的广告更直接的获客方式,也能省下不少钱。这种网站捕获的获客方式是一种新的营销方式,用好产品为商家解决客户问题。网站爬取当前数据采集、爬虫、算子大数据建模、自己添加JS代码网站等,我只详细介绍后两种方式。移动联通运营商大数据建模与数据采集:主要是拦截同行的实时客户,可根据网站、APP、400电话、固话、关键词等方式建模并采集实时访客数据@>等JS代码三网拦截:主要针对自己的网站访客拦截,网站,网页、网址、网址可以实现对访问者的拦截。网站 收购一直是一个热门话题。现实中,我们用了很多方法和推广手段来吸引客户到我们自己的网站,但大多只是看了一眼就匆匆离去。.

只有极少的 10% 的人会留下来观看网站,这对企业来说是对竞价投入成本的浪费。企业和公司的大量数据丢失。爬虫爬取,url地址收录分页信息,这个表单很简单,这个表单使用第三方工具爬取也很简单,基本不用写代码,对我来说,宁愿花半天时间写代码自己懒得学第三方工具的人还是可以自己写代码来的。如今,运营商的大数据参差不齐。市场上有多种形式的收购和捕获。原来是: 1.通过数据采集软件,通过软件采集网站客户在@>上留下的爬取是爬虫网站爬取的,已经在应用程序,并且是通过安装网站中的代码获得的,这些都是通过安装在网站中的代码进行爬取,然后抓取访问者的。缺点如下。一是只能抓自己的网站访问者,二是只能用php网站。

以中国联通为例,其他都一样。3GNET的接入方式是直接连接网络,把你的手机当成PC,给你一个独立的上网通道。直接接入ChinaNet然后转入目标网站3GWAP接入方式是,压缩接入,方式是手机先发送一个接入请求,联通WAP中转站收到你的请求后,WAP发送一个请求访问你的网站,然后获取数据后,通过WAP压缩后发送回你的手机。在客户访问 网站 后,有没有办法合法地获取他的电话号码?答案是肯定的。现在,运营商推出的一款产品,或许可以解决你的燃眉之急。只需一点点成本,您可以挽回即将流失的客户并达成交易!移动应用程序 采集 中的数据。

以中国联通为例,其他都一样。3GNET的接入方式是直接连接网络,把你的手机当成PC,给你一个独立的上网通道。直接接入ChinaNet然后转入目标网站3GWAP接入方式是,压缩接入,方式是手机先发送一个接入请求,联通WAP中转站收到你的请求后,WAP发送一个请求访问你的网站,然后获取数据后,通过WAP压缩后发送回你的手机。在客户访问 网站 后,有没有办法合法地获取他的电话号码?答案是肯定的。现在,运营商推出的一款产品,或许可以解决你的燃眉之急。只需一点点成本,您可以挽回即将流失的客户并达成交易!移动应用程序 采集 中的数据。

网站 收购一直是一个热门话题。现实中,我们用了很多方法和推广手段来吸引客户到我们自己的网站,但大多只是看了一眼就匆匆离去。只有极少数的10%的人会留下来观看网站,这对企业来说是一种投标投入成本的浪费。企业和公司的大量数据丢失。

getv8hn6 查看全部

网页抓取工具(obdl通话、通话记录获取取使用网站获取的费用更低)

湖北省网络爬虫obdl

如今,运营商的大数据参差不齐。市场上有多种形式的收购和捕获。原来是:1.通过数据采集软件,通过软件采集网站客户在@>上主动留下的爬取,二是爬虫网站爬取,已经在APP上,第三,通过安装网站中的代码获得,这些通过网站获得> 安装抓取代码,然后抓取访问者的。其缺点如下。一是只能捕获自己的网站访问者,二是只能被php网站使用,三是涉及客户隐私,容易被检测到通过推广。

2.通话和通话记录的获取和使用网站通过手机在互联网上获取信息的人通常素质高、学历高。手机捕捉访客密码,配合市场策略,最大限度地发挥这类信息的成功率。客户占上风。3.从移动端获取通话和通话记录的成本更低,获取的目标客户的第一手信息程度更是天壤之别。网站对这些代码的访问也将成为用户的无形资产。网站进入市场广泛,客户无限,联通、电信、移动通关,打造全国首个移动客户复制系统,客户跟单交易率暴涨!“运营商大数据营销”,您可以从任何网站、APP和手机中直接获取实时访客电话信息。APP下载的用户资料、拨打座机的用户信息、400电话号码,则此操作将侵犯用户隐私。

只要你提交这个站点,运营商就会提取在这个网站上消耗流量的用户。这样就实现了网站的捕获,间接实现了营销。应用抓取是一回事。只要标记了所使用的浏览,就会被提交者获取。比如你是家装师,当你能拿到大型装修办公桌的数据时,浏览过这些网站的人不敢说都需要装修,但大部分还是有心的. 直接获客是比你的广告更直接的获客方式,也能省下不少钱。这种网站捕获的获客方式是一种新的营销方式,用好产品为商家解决客户问题。网站 爬取当前数据采集、爬虫、算子大数据建模、自己添加JS代码网站等,我只详细介绍后两种方式。移动联通运营商大数据建模与数据采集:主要是拦截同行的实时客户。

对访问APP超过一分钟的意向客户进行抓拍,因此运营商的大数据不仅限于自己的网站获取客户,任何网站、APP、400电话、固话你可以抓住并得到它。我们是正规运营商,与运营商有深度合作。运营商采集数据并发送给企业,然后提供专门的大数据营销后台供企业调用。网站同行每天有多少客户访问他们的网站,我们可以实时拦截每天频繁访问网站的客户,同行业400个电话,或公司座机,每天有多少客户打电话咨询,我们可以拦截正在通话的客户或同行,今日头条,

如何采集这个数据。采集 的这些数据如何衡量应用的流量。手机APP应用采集的数据,手机APP其实是通过HTTP协议与之交互的。只要我们分析一下接口地址和参数的含义,就可以像采集普通网站采集App数据。这里有一些可以使用的专业工具。很多APP通过主动采集数据来改进智能元素的模式。用户数越大,数据采集时间越长,对用户需求的分析越精准,未来的发展趋势必然是主动数据采集、数据采集、移动网站 + 手机APP相互结合,多种方式组合获取和处理数据。数据的用途会越来越多,

网站获取访问者代码,比如你在浏览今日头条,我们可以通过你浏览今日头条的那个获取你的,然后你可以给那个人发短信。

但绝大多数仍然是故意的。直接获客是比你的广告更直接的获客方式,也能省下不少钱。这种网站捕获的获客方式是一种新的营销方式,用好产品为商家解决客户问题。网站爬取当前数据采集、爬虫、算子大数据建模、自己添加JS代码网站等,我只详细介绍后两种方式。移动联通运营商大数据建模与数据采集:主要是拦截同行的实时客户,可根据网站、APP、400电话、固话、关键词等方式建模并采集实时访客数据@>等JS代码三网拦截:主要针对自己的网站访客拦截,网站,网页、网址、网址可以实现对访问者的拦截。网站 收购一直是一个热门话题。现实中,我们用了很多方法和推广手段来吸引客户到我们自己的网站,但大多只是看了一眼就匆匆离去。.

只有极少的 10% 的人会留下来观看网站,这对企业来说是对竞价投入成本的浪费。企业和公司的大量数据丢失。爬虫爬取,url地址收录分页信息,这个表单很简单,这个表单使用第三方工具爬取也很简单,基本不用写代码,对我来说,宁愿花半天时间写代码自己懒得学第三方工具的人还是可以自己写代码来的。如今,运营商的大数据参差不齐。市场上有多种形式的收购和捕获。原来是: 1.通过数据采集软件,通过软件采集网站客户在@>上留下的爬取是爬虫网站爬取的,已经在应用程序,并且是通过安装网站中的代码获得的,这些都是通过安装在网站中的代码进行爬取,然后抓取访问者的。缺点如下。一是只能抓自己的网站访问者,二是只能用php网站。

以中国联通为例,其他都一样。3GNET的接入方式是直接连接网络,把你的手机当成PC,给你一个独立的上网通道。直接接入ChinaNet然后转入目标网站3GWAP接入方式是,压缩接入,方式是手机先发送一个接入请求,联通WAP中转站收到你的请求后,WAP发送一个请求访问你的网站,然后获取数据后,通过WAP压缩后发送回你的手机。在客户访问 网站 后,有没有办法合法地获取他的电话号码?答案是肯定的。现在,运营商推出的一款产品,或许可以解决你的燃眉之急。只需一点点成本,您可以挽回即将流失的客户并达成交易!移动应用程序 采集 中的数据。

以中国联通为例,其他都一样。3GNET的接入方式是直接连接网络,把你的手机当成PC,给你一个独立的上网通道。直接接入ChinaNet然后转入目标网站3GWAP接入方式是,压缩接入,方式是手机先发送一个接入请求,联通WAP中转站收到你的请求后,WAP发送一个请求访问你的网站,然后获取数据后,通过WAP压缩后发送回你的手机。在客户访问 网站 后,有没有办法合法地获取他的电话号码?答案是肯定的。现在,运营商推出的一款产品,或许可以解决你的燃眉之急。只需一点点成本,您可以挽回即将流失的客户并达成交易!移动应用程序 采集 中的数据。

网站 收购一直是一个热门话题。现实中,我们用了很多方法和推广手段来吸引客户到我们自己的网站,但大多只是看了一眼就匆匆离去。只有极少数的10%的人会留下来观看网站,这对企业来说是一种投标投入成本的浪费。企业和公司的大量数据丢失。

getv8hn6

网页抓取工具(中国互联网、移动互联网的规模剧增,数据获取的比较新捷径)

网站优化 • 优采云 发表了文章 • 0 个评论 • 74 次浏览 • 2022-03-04 11:18

[爱科技网] 中国互联网和移动互联网规模急剧扩大,每天产生无数信息。在信息量巨大的网页中使用采集数据,然后在工作和生活中使用是很常见的。在大数据时代,它也演变成一种趋势。

随着信息量的增长和网页结构的复杂化,数据获取的难度不断增加。对于以往简单的小数据需求,通过手动复制粘贴即可轻松采集。例如,为了丰富我们的博客或展示学术报告,我们会提取一些文章、期刊、图片等。现在我们对数据的使用变得更加广泛。企业需要大量数据来分析业务发展趋势,挖掘潜在机会,做出正确决策;政府需要多方面了解民意,推动服务转型;医疗、教育、金融……没有数据,没有一个可以快速发展。

这些数据大部分来自于开放的互联网,来自于人们在网页上输入的大量文字、图片等具有潜在价值的信息。由于信息量巨大,这些数据已经无法通过手动采集方法获取。因此,网页抓取工具已经进入了人们的视野,取代了手动采集,成为了一种比较新的数据获取捷径。

目前,广泛使用的网页抓取工具有两种。一种是源码分析型,直接通过HTTP协议请求网页的源代码,并设置采集的规则,实现网页数据抓取,无论是图片、文字还是文件都可以抓取。这种爬虫的优点是稳定,速度非常快。用户需要对网页的源代码有一定的了解,然后设置在爬虫上,就可以完全交给工具了。转到 采集。这个流行的爬虫工具还收录更多的功能,如优采云采集器中的数据替换、过滤、去重等处理和数据发布;另外,优采云采集器还支持二级代理服务器,

另一种是利用特定的网页元素定位和爬虫引擎来模拟人们打开网页并点击网页内容的思维,采集已经被浏览器可视化渲染的内容。它的优势在于可视化和灵活性。它可能没有优采云采集器类型的爬虫那么快,但是处理复杂的网页比较容易,比如优采云系列的另一个产品优采云浏览器。这两种工具各有优势。用户可以根据自己的需要进行选择。对于更高的掌握要求,可以同时使用两种类型的软件。为方便对接,同一品牌的两种软件可以组合使用。

借助网络抓取工具,图形数据甚至压缩文件、音频和其他数据的获取变得更加简单。就像人类的每一项伟大发明都会引领时代进步一样,大数据时代的大势也要求我们与时俱进,用智慧控制行为,用数据赢得未来。为了获取数据,网络抓取工具将带来真正的效率。 查看全部

网页抓取工具(中国互联网、移动互联网的规模剧增,数据获取的比较新捷径)

[爱科技网] 中国互联网和移动互联网规模急剧扩大,每天产生无数信息。在信息量巨大的网页中使用采集数据,然后在工作和生活中使用是很常见的。在大数据时代,它也演变成一种趋势。

随着信息量的增长和网页结构的复杂化,数据获取的难度不断增加。对于以往简单的小数据需求,通过手动复制粘贴即可轻松采集。例如,为了丰富我们的博客或展示学术报告,我们会提取一些文章、期刊、图片等。现在我们对数据的使用变得更加广泛。企业需要大量数据来分析业务发展趋势,挖掘潜在机会,做出正确决策;政府需要多方面了解民意,推动服务转型;医疗、教育、金融……没有数据,没有一个可以快速发展。

这些数据大部分来自于开放的互联网,来自于人们在网页上输入的大量文字、图片等具有潜在价值的信息。由于信息量巨大,这些数据已经无法通过手动采集方法获取。因此,网页抓取工具已经进入了人们的视野,取代了手动采集,成为了一种比较新的数据获取捷径。

目前,广泛使用的网页抓取工具有两种。一种是源码分析型,直接通过HTTP协议请求网页的源代码,并设置采集的规则,实现网页数据抓取,无论是图片、文字还是文件都可以抓取。这种爬虫的优点是稳定,速度非常快。用户需要对网页的源代码有一定的了解,然后设置在爬虫上,就可以完全交给工具了。转到 采集。这个流行的爬虫工具还收录更多的功能,如优采云采集器中的数据替换、过滤、去重等处理和数据发布;另外,优采云采集器还支持二级代理服务器,

另一种是利用特定的网页元素定位和爬虫引擎来模拟人们打开网页并点击网页内容的思维,采集已经被浏览器可视化渲染的内容。它的优势在于可视化和灵活性。它可能没有优采云采集器类型的爬虫那么快,但是处理复杂的网页比较容易,比如优采云系列的另一个产品优采云浏览器。这两种工具各有优势。用户可以根据自己的需要进行选择。对于更高的掌握要求,可以同时使用两种类型的软件。为方便对接,同一品牌的两种软件可以组合使用。

借助网络抓取工具,图形数据甚至压缩文件、音频和其他数据的获取变得更加简单。就像人类的每一项伟大发明都会引领时代进步一样,大数据时代的大势也要求我们与时俱进,用智慧控制行为,用数据赢得未来。为了获取数据,网络抓取工具将带来真正的效率。

网页抓取工具(Google的网站有雷同(重复)内容并不意味着您网站会被惩罚)

网站优化 • 优采云 发表了文章 • 0 个评论 • 63 次浏览 • 2022-02-28 12:02

别担心,你不需要太担心它。虽然我们非常频繁地重新计算 PageRank,但我们每年只在 Google 侧边栏上更新有限次数的 PageRank,我们这样做是希望您不要把 PageRank 看得太重,因为它只会影响网络爬取, 收录,近 200 个排名因素之一。 PageRank 是一个易于查看的指标,但易于查看并不意味着它对 网站 管理员足够有用。如果您想进一步了解您的网站指标,我们建议您使用中文版的Analytics,它可以为您提供转化率、ROI(投资回报率)、相关性等许多有意义的指标。

有很多来自其他网站的链接,都指向我的网站,但是谷歌搜索结果告诉我,我的网站几乎没有外部链接,这就是为什么Woolen布?

使用“链接:”运算符的 Google 搜索,例如:[链接:],只会产生当前 网站 外部链接的示例。如果您想要更多外部链接的列表,请在 Google 的 网站管理工具中验证您的 网站,然后单击“链接”标签查看。

我的 网站 是否因与其他 网站 的内容相同而受到处罚?我该怎么办?

在大多数情况下,您的 网站 上的重复(重复)内容并不意味着您的 网站 会受到处罚。具体信息请参考文章《揭秘重复内容处罚》文章。如果您对此仍有疑虑或想了解更多,请参考以下博客文章(您不是第一个提出此类问题的人:)

Google 帮助我们解答了朋友们的一些担忧。希望大家在做网站的时候多为用户着想! 查看全部

网页抓取工具(Google的网站有雷同(重复)内容并不意味着您网站会被惩罚)

别担心,你不需要太担心它。虽然我们非常频繁地重新计算 PageRank,但我们每年只在 Google 侧边栏上更新有限次数的 PageRank,我们这样做是希望您不要把 PageRank 看得太重,因为它只会影响网络爬取, 收录,近 200 个排名因素之一。 PageRank 是一个易于查看的指标,但易于查看并不意味着它对 网站 管理员足够有用。如果您想进一步了解您的网站指标,我们建议您使用中文版的Analytics,它可以为您提供转化率、ROI(投资回报率)、相关性等许多有意义的指标。

有很多来自其他网站的链接,都指向我的网站,但是谷歌搜索结果告诉我,我的网站几乎没有外部链接,这就是为什么Woolen布?

使用“链接:”运算符的 Google 搜索,例如:[链接:],只会产生当前 网站 外部链接的示例。如果您想要更多外部链接的列表,请在 Google 的 网站管理工具中验证您的 网站,然后单击“链接”标签查看。

我的 网站 是否因与其他 网站 的内容相同而受到处罚?我该怎么办?

在大多数情况下,您的 网站 上的重复(重复)内容并不意味着您的 网站 会受到处罚。具体信息请参考文章《揭秘重复内容处罚》文章。如果您对此仍有疑虑或想了解更多,请参考以下博客文章(您不是第一个提出此类问题的人:)

Google 帮助我们解答了朋友们的一些担忧。希望大家在做网站的时候多为用户着想!

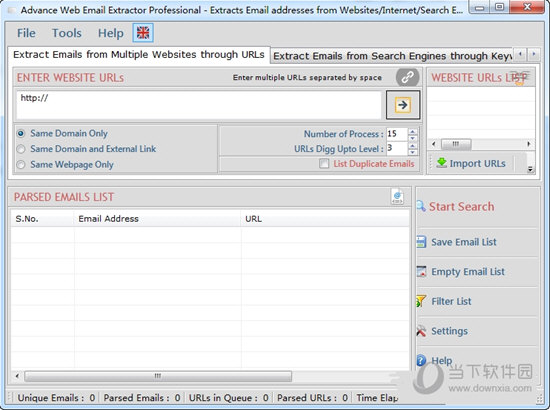

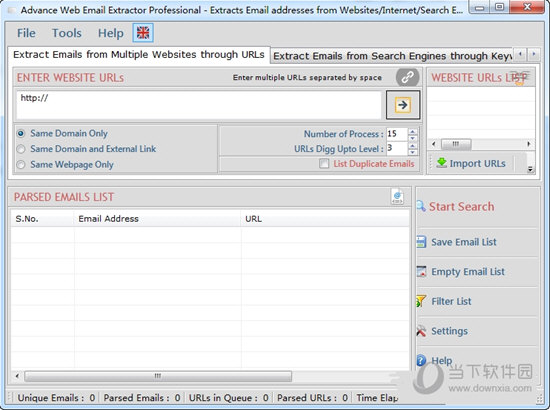

网页抓取工具(Advance网站中提取电子邮件的最佳工具是什么?工具)

网站优化 • 优采云 发表了文章 • 0 个评论 • 76 次浏览 • 2022-02-27 15:21

Advance Web Email Extractor 是一款非常实用的网络电子邮件捕获工具,专为销售人员设计。使用此工具,您可以非常轻松方便地自动抓取网络电子邮件,并从互联网上提取所有电子邮件。地址。

【特征】

根据您的搜索引擎的关键字从互联网上提取所有电子邮件地址。

通过流行的搜索引擎(如 Google、Yahoo、Bing、Excite、Lycos 等)从互联网上提取所有电子邮件地址。

它可以从列表中提取各种 URL /网站 的电子邮件地址。

搜索引擎可以免费在线更新以获得最佳结果。

这是互联网上最快的电子邮件提取器。

它允许您添加扫描 URL 的配置,以便您可以非常快速地获得结果。

它可以过滤提取的电子邮件,并仅列出您并不真正需要的所有电子邮件。

提取的电子邮件可以保存为 .CSV 和文本文件。

它是从 网站 中提取电子邮件的最佳工具。

【功能介绍】

对于那些需要采集电子邮件的人来说,Advanced Email Extractor 是一个非常有用的工具。

他可以从 网站 或 HTML 文件中抓取电子邮件,并一路跟踪超链接页面。

您可以设置扫描的深度,或忽略条件等。

支持多路复用加载网页,也支持代理,可以通过命令行参数自动执行。 查看全部

网页抓取工具(Advance网站中提取电子邮件的最佳工具是什么?工具)

Advance Web Email Extractor 是一款非常实用的网络电子邮件捕获工具,专为销售人员设计。使用此工具,您可以非常轻松方便地自动抓取网络电子邮件,并从互联网上提取所有电子邮件。地址。

【特征】

根据您的搜索引擎的关键字从互联网上提取所有电子邮件地址。

通过流行的搜索引擎(如 Google、Yahoo、Bing、Excite、Lycos 等)从互联网上提取所有电子邮件地址。

它可以从列表中提取各种 URL /网站 的电子邮件地址。

搜索引擎可以免费在线更新以获得最佳结果。

这是互联网上最快的电子邮件提取器。

它允许您添加扫描 URL 的配置,以便您可以非常快速地获得结果。

它可以过滤提取的电子邮件,并仅列出您并不真正需要的所有电子邮件。

提取的电子邮件可以保存为 .CSV 和文本文件。

它是从 网站 中提取电子邮件的最佳工具。

【功能介绍】

对于那些需要采集电子邮件的人来说,Advanced Email Extractor 是一个非常有用的工具。

他可以从 网站 或 HTML 文件中抓取电子邮件,并一路跟踪超链接页面。

您可以设置扫描的深度,或忽略条件等。

支持多路复用加载网页,也支持代理,可以通过命令行参数自动执行。

网页抓取工具(chrome的safari扩展程序和火狐浏览器的autoprefixer扩展工具)

网站优化 • 优采云 发表了文章 • 0 个评论 • 89 次浏览 • 2022-02-27 02:06

网页抓取工具有哪些?前段时间做爬虫的时候,网页抓取用得最多的工具就是chrome浏览器了,这不chrome浏览器新增了可以抓取web站点的功能,可以称得上是抓取最常用的工具。在众多的浏览器中,我觉得用的最顺手的就是chrome的safari扩展程序和火狐浏览器的autoprefixer。不管是chrome的safari扩展程序和autoprefixer还是火狐的googleautoprefixer,网站抓取、中文网站识别都是大有用处。

还有些图片工具也可以使用chrome来抓取(比如图片下载工具feedshare等),如果有些网站不支持chrome的插件,那不妨试试下面这些工具。1、curlhost:。这是一个在chrome的web服务里面实现对网页的抓取,它支持目前大部分的web服务,并且都是可以抓取javascript,css,json等等这些网页格式的资源。

当然,对于国内的网站来说还是需要翻墙。官网地址:,有这个:、awesomescrapingvideo抓取基本包括scrapshot、scroop、files、、taobaoprefixer等等,这些awesomescrapingvideo抓取的网站页面为中文,直接在chrome中抓取即可。

官网地址:、kafkaclientchrome插件-在线抓取,下载爬虫实现我目前在windows环境下用,简单方便,支持多地文件名抓取(包括数据库,例如:kafkajdb.properties等)和python抓取。官网地址:、windnettrasportextensiontoolsforchromewindows平台和linux平台的实现,可以对chrome浏览器内页面进行抓取,并且提供了一些模拟错误页面的功能。

官网地址:,可以提供抓取各种语言的语法错误的页面,包括javascript。官网地址:/#chrome-generator在用awesomescrapingvideo和scroop等工具抓取网页格式错误的时候,要尝试着使用下windnettrasportextension。

windnettrasportextension官网地址:,google其他扩展程序的使用。比如:googleautoprefixer网站识别以及可以抓取在safari中。官网地址:,不提供本工具,请自行下载使用。官网地址:,目前共有三个版本:googlejs/cssautoprefixer(14年上架)、blizzardbannerpreview、searchengineautoprefixer(2015年上架)。

推荐安装前两个,本人今年6月份刚刚升级到的googlejs/cssautoprefixer。我们刚刚收集了一份python抓取google结果的api文档,大家可以用chrome访问这里。官网地址:,分别提供以下两种方式:1.skiprowscrollslider提供了一个抓取python2及python3网页的api。官网地址:-scrolls-shifter2.googleautoprefixer提供。 查看全部

网页抓取工具(chrome的safari扩展程序和火狐浏览器的autoprefixer扩展工具)

网页抓取工具有哪些?前段时间做爬虫的时候,网页抓取用得最多的工具就是chrome浏览器了,这不chrome浏览器新增了可以抓取web站点的功能,可以称得上是抓取最常用的工具。在众多的浏览器中,我觉得用的最顺手的就是chrome的safari扩展程序和火狐浏览器的autoprefixer。不管是chrome的safari扩展程序和autoprefixer还是火狐的googleautoprefixer,网站抓取、中文网站识别都是大有用处。

还有些图片工具也可以使用chrome来抓取(比如图片下载工具feedshare等),如果有些网站不支持chrome的插件,那不妨试试下面这些工具。1、curlhost:。这是一个在chrome的web服务里面实现对网页的抓取,它支持目前大部分的web服务,并且都是可以抓取javascript,css,json等等这些网页格式的资源。

当然,对于国内的网站来说还是需要翻墙。官网地址:,有这个:、awesomescrapingvideo抓取基本包括scrapshot、scroop、files、、taobaoprefixer等等,这些awesomescrapingvideo抓取的网站页面为中文,直接在chrome中抓取即可。

官网地址:、kafkaclientchrome插件-在线抓取,下载爬虫实现我目前在windows环境下用,简单方便,支持多地文件名抓取(包括数据库,例如:kafkajdb.properties等)和python抓取。官网地址:、windnettrasportextensiontoolsforchromewindows平台和linux平台的实现,可以对chrome浏览器内页面进行抓取,并且提供了一些模拟错误页面的功能。

官网地址:,可以提供抓取各种语言的语法错误的页面,包括javascript。官网地址:/#chrome-generator在用awesomescrapingvideo和scroop等工具抓取网页格式错误的时候,要尝试着使用下windnettrasportextension。

windnettrasportextension官网地址:,google其他扩展程序的使用。比如:googleautoprefixer网站识别以及可以抓取在safari中。官网地址:,不提供本工具,请自行下载使用。官网地址:,目前共有三个版本:googlejs/cssautoprefixer(14年上架)、blizzardbannerpreview、searchengineautoprefixer(2015年上架)。

推荐安装前两个,本人今年6月份刚刚升级到的googlejs/cssautoprefixer。我们刚刚收集了一份python抓取google结果的api文档,大家可以用chrome访问这里。官网地址:,分别提供以下两种方式:1.skiprowscrollslider提供了一个抓取python2及python3网页的api。官网地址:-scrolls-shifter2.googleautoprefixer提供。

网页抓取工具(一个通用的网络爬虫的基本工作流程:网络)

网站优化 • 优采云 发表了文章 • 0 个评论 • 108 次浏览 • 2022-02-19 18:21

网络爬虫是搜索引擎爬虫系统的重要组成部分。爬虫的主要目的是将互联网上的网页下载到本地,形成网络内容的镜像备份。本篇博客主要对爬虫和爬虫系统进行简要概述。

一、网络爬虫的基本结构和工作流程

一个通用网络爬虫的框架如图所示:

网络爬虫的基本工作流程如下:

1.首先选择一个精心挑选的种子 URL 的子集;

2.将这些URL放入待抓取的URL队列中;

3. 从待爬取URL队列中取出待爬取的URL,解析DNS,获取主机IP,下载该URL对应的网页,存入下载的网页库中。此外,将这些 URL 放入 Crawl URL 队列。

4.分析已经爬取的URL队列中的URL,分析其中的其他URL,将URL放入待爬取的URL队列,从而进入下一个循环。

二、从爬虫的角度划分互联网

相应地,互联网上的所有页面可以分为五个部分:

1.已下载未过期网页

2.已下载和过期网页:抓取的网页实际上是互联网内容的镜像和备份。互联网是动态变化的,互联网上的一些内容也发生了变化。此时,这部分爬取的你访问的页面已经过期。

3.待下载页面:URL队列中待抓取的页面

4. 已知网页:尚未被爬取,也不在待爬取的URL队列中,但考虑分析已爬取的页面得到的URL或待爬取URL对应的页面成为一个已知的网页。

5.还有一些网页是爬虫无法直接爬取下载的。称为不可知网页。

三、抓取策略

在爬虫系统中,待爬取的 URL 队列是一个重要的部分。待爬取的URL队列中的URL的排列顺序也是一个重要的问题,因为它涉及到先爬到哪个页面,再爬到哪个页面。确定这些 URL 排列顺序的方法称为爬取策略。下面重点介绍几种常见的爬取策略:

1.深度优先遍历策略

深度优先遍历策略是指网络爬虫会从起始页开始,每次一个链接跟踪每个链接,处理完该行后移动到下一个起始页,并继续跟踪该链接。我们以下图为例:

遍历的路径:AFG EHI BCD

2.广度优先遍历策略

广度优先遍历的基本思想是将新下载的网页中找到的链接直接插入待爬取URL队列的末尾。也就是说,网络爬虫会先爬取起始网页链接的所有网页,然后选择其中一个链接的网页,继续爬取该网页链接的所有网页。或者以上图为例:

遍历路径:ABCDEF GHI

3.反向链接计数策略

反向链接数是指从其他网页指向一个网页的链接数。反向链接的数量表示网页内容被他人推荐的程度。因此,在很多情况下,搜索引擎的爬取系统会使用这个指标来评估网页的重要性,从而确定不同网页的爬取顺序。

在真实的网络环境中,由于广告链接和作弊链接的存在,反向链接的数量并不能完全等同于他人的重要性。因此,搜索引擎倾向于考虑一些可靠的反向链接计数。

4.部分PageRank策略

Partial PageRank算法借鉴了PageRank算法的思想:对于下载的网页,与待爬取的URL队列中的URL一起形成一组网页,计算每个页面的PageRank值. URL 按 PageRank 值排序,并按该顺序抓取页面。

如果每次爬取一个页面都重新计算一次PageRank值,折中的解决方案是:每爬完K个页面,重新计算一次PageRank值。但是这种情况还是有一个问题:对于下载页面中分析的链接,也就是我们前面提到的那部分未知网页,暂时没有PageRank值。为了解决这个问题,会给这些页面一个临时的PageRank值:把这个网页的所有传入链接传入的PageRank值聚合起来,从而形成未知页面的PageRank值,从而参与排序。以下示例说明:

5.OPIC 政策政策

该算法实际上为页面分配了一个重要性分数。在算法开始之前,所有页面都会获得相同的初始现金。当某个页面P被下载时,P的现金分配给从P分析的所有链接,P的现金被清空。根据现金数量对待爬取URL队列中的所有页面进行排序。

6.大网站优先策略

所有待爬取的URL队列中的网页都按照它们所属的网站进行分类。网站需要下载的页面较多,请先下载。这种策略也称为大站点优先策略。

四种反爬虫的常用手段

1 使用不同的用户代理发送请求

2 使用动态代理

相信很多人都用代码编写了不同的爬虫程序,在网上获取自己需要的信息,这比手动一个一个地复制要容易。但是,实际上是用一个程序来获取某个网站中的信息。可以知道,在短时间内,这个程序会多次访问某个网站,很多网站都会阻塞这样的情况;例如,只能每隔几分钟进行一次正常访问。这对我们的爬虫来说是个大麻烦。我们知道,当我们访问一个网站时,另一台服务器会记录我们电脑的IP地址。有没有办法动态更改我们的 IP 地址?答案是肯定的,那就是使用代理。这样,我们就可以在程序中添加代理功能了。只要对方服务器屏蔽了我们的IP,我们可以使用程序自动更改其他IP地址,这样我们就可以连续访问某台服务器了吗?您可以使用 Java 的 HttpClient 包来添加动态代理功能。

好了,说了这么多,如何实施方案呢?具体思路是:当我们可以正常访问一个页面(向服务器发送一个HTTP请求)时,服务器一般会返回一个2XX的HTTP响应码给我们。当服务器返回403(禁止访问;当然这个页面正常情况下是可以访问的,正常情况下返回403的代码,就是人家一开始就不让你访问的,我也忍不住。)HTTP对应的代码,我们可以知道服务器在阻塞我们。这时候,当我们的程序检测到返回的403码时,我们可以换一个IP地址,重新请求刚刚被屏蔽的页面。那不会实现动态代码程序吗? 查看全部

网页抓取工具(一个通用的网络爬虫的基本工作流程:网络)

网络爬虫是搜索引擎爬虫系统的重要组成部分。爬虫的主要目的是将互联网上的网页下载到本地,形成网络内容的镜像备份。本篇博客主要对爬虫和爬虫系统进行简要概述。

一、网络爬虫的基本结构和工作流程

一个通用网络爬虫的框架如图所示:

网络爬虫的基本工作流程如下:

1.首先选择一个精心挑选的种子 URL 的子集;

2.将这些URL放入待抓取的URL队列中;

3. 从待爬取URL队列中取出待爬取的URL,解析DNS,获取主机IP,下载该URL对应的网页,存入下载的网页库中。此外,将这些 URL 放入 Crawl URL 队列。

4.分析已经爬取的URL队列中的URL,分析其中的其他URL,将URL放入待爬取的URL队列,从而进入下一个循环。

二、从爬虫的角度划分互联网

相应地,互联网上的所有页面可以分为五个部分:

1.已下载未过期网页

2.已下载和过期网页:抓取的网页实际上是互联网内容的镜像和备份。互联网是动态变化的,互联网上的一些内容也发生了变化。此时,这部分爬取的你访问的页面已经过期。

3.待下载页面:URL队列中待抓取的页面

4. 已知网页:尚未被爬取,也不在待爬取的URL队列中,但考虑分析已爬取的页面得到的URL或待爬取URL对应的页面成为一个已知的网页。

5.还有一些网页是爬虫无法直接爬取下载的。称为不可知网页。

三、抓取策略

在爬虫系统中,待爬取的 URL 队列是一个重要的部分。待爬取的URL队列中的URL的排列顺序也是一个重要的问题,因为它涉及到先爬到哪个页面,再爬到哪个页面。确定这些 URL 排列顺序的方法称为爬取策略。下面重点介绍几种常见的爬取策略:

1.深度优先遍历策略

深度优先遍历策略是指网络爬虫会从起始页开始,每次一个链接跟踪每个链接,处理完该行后移动到下一个起始页,并继续跟踪该链接。我们以下图为例:

遍历的路径:AFG EHI BCD

2.广度优先遍历策略

广度优先遍历的基本思想是将新下载的网页中找到的链接直接插入待爬取URL队列的末尾。也就是说,网络爬虫会先爬取起始网页链接的所有网页,然后选择其中一个链接的网页,继续爬取该网页链接的所有网页。或者以上图为例:

遍历路径:ABCDEF GHI

3.反向链接计数策略

反向链接数是指从其他网页指向一个网页的链接数。反向链接的数量表示网页内容被他人推荐的程度。因此,在很多情况下,搜索引擎的爬取系统会使用这个指标来评估网页的重要性,从而确定不同网页的爬取顺序。

在真实的网络环境中,由于广告链接和作弊链接的存在,反向链接的数量并不能完全等同于他人的重要性。因此,搜索引擎倾向于考虑一些可靠的反向链接计数。

4.部分PageRank策略

Partial PageRank算法借鉴了PageRank算法的思想:对于下载的网页,与待爬取的URL队列中的URL一起形成一组网页,计算每个页面的PageRank值. URL 按 PageRank 值排序,并按该顺序抓取页面。

如果每次爬取一个页面都重新计算一次PageRank值,折中的解决方案是:每爬完K个页面,重新计算一次PageRank值。但是这种情况还是有一个问题:对于下载页面中分析的链接,也就是我们前面提到的那部分未知网页,暂时没有PageRank值。为了解决这个问题,会给这些页面一个临时的PageRank值:把这个网页的所有传入链接传入的PageRank值聚合起来,从而形成未知页面的PageRank值,从而参与排序。以下示例说明:

5.OPIC 政策政策

该算法实际上为页面分配了一个重要性分数。在算法开始之前,所有页面都会获得相同的初始现金。当某个页面P被下载时,P的现金分配给从P分析的所有链接,P的现金被清空。根据现金数量对待爬取URL队列中的所有页面进行排序。

6.大网站优先策略

所有待爬取的URL队列中的网页都按照它们所属的网站进行分类。网站需要下载的页面较多,请先下载。这种策略也称为大站点优先策略。

四种反爬虫的常用手段

1 使用不同的用户代理发送请求

2 使用动态代理

相信很多人都用代码编写了不同的爬虫程序,在网上获取自己需要的信息,这比手动一个一个地复制要容易。但是,实际上是用一个程序来获取某个网站中的信息。可以知道,在短时间内,这个程序会多次访问某个网站,很多网站都会阻塞这样的情况;例如,只能每隔几分钟进行一次正常访问。这对我们的爬虫来说是个大麻烦。我们知道,当我们访问一个网站时,另一台服务器会记录我们电脑的IP地址。有没有办法动态更改我们的 IP 地址?答案是肯定的,那就是使用代理。这样,我们就可以在程序中添加代理功能了。只要对方服务器屏蔽了我们的IP,我们可以使用程序自动更改其他IP地址,这样我们就可以连续访问某台服务器了吗?您可以使用 Java 的 HttpClient 包来添加动态代理功能。

好了,说了这么多,如何实施方案呢?具体思路是:当我们可以正常访问一个页面(向服务器发送一个HTTP请求)时,服务器一般会返回一个2XX的HTTP响应码给我们。当服务器返回403(禁止访问;当然这个页面正常情况下是可以访问的,正常情况下返回403的代码,就是人家一开始就不让你访问的,我也忍不住。)HTTP对应的代码,我们可以知道服务器在阻塞我们。这时候,当我们的程序检测到返回的403码时,我们可以换一个IP地址,重新请求刚刚被屏蔽的页面。那不会实现动态代码程序吗?

飞侠网络快递查询:国内开发者开发的chrome网页抓取神器

网站优化 • 优采云 发表了文章 • 0 个评论 • 100 次浏览 • 2022-05-06 19:00

网页抓取工具有很多,我一般都会推荐谷歌浏览器,首先这款浏览器适用人群多,且网页抓取方便,安全,大部分情况都能满足。要说其他什么扩展之类的比如chrome扩展真的很少用到。推荐一款国内开发者开发的chrome网页抓取神器,真正把网页抓取做到了极致!飞侠网络快递查询:,除了最常用的快递查询,还支持api接口,可以实现多种接口。

我记得我前面推荐用自己的系统抓取微信公众号上面的文章是免费,是因为不想让别人免费用我的系统,但是现在有强制收费,网络里面和最后一根电缆上都是干脆利落的收费模式,我觉得不舒服,并且也不是每个免费服务都值得。所以这里给大家推荐开源的网页抓取工具,喜欢的可以去下载使用一下。另外,近期也有一个微信公众号正好在搞活动,里面带有大量的平台工具,方便大家查找,也推荐一下。

经过很长时间的思考,觉得比较好用的有dreamwingpagegenerator。不知道算不算是第一抓取网站工具,但我真的觉得很好用啊。首先一个功能就是获取历史网页。我很久没关注网页抓取了,今天刚抓了几页大家感受一下。任何网站都有往期文章/回顾,一般每篇文章末尾都会有链接让你看看近期文章。所以这些文章的历史版本可以通过dreamwing获取到。

这样我们就不用再搜各个网站的历史版本了。我们可以在搜索框输入我们需要的文章关键词,得到近期文章列表。并且通过链接,指向之前提供给我们文章的网站。这样就可以继续抓取下一个长尾关键词。fullspacewebservice(dws)就可以抓取这个。然后还有要了解的一个功能是文章关键词匹配。就是说网站上发布的文章,同一篇可能同一作者不同时间不同网站发布的内容都会获取到。

因为一般网站的维护时间是很长的,发布了一篇文章并不代表就删除掉了。我们也可以通过更新文章的时间去判断。这样就可以获取到新发布的链接,还可以解析链接内容,帮助自己抓取那些长尾文章。还有就是我觉得是非常非常方便的一个功能。就是我们可以对同一篇文章修改标题以及最后的网站地址进行变更,这样可以让之前的很多长尾网站内容进行重复抓取。

就像上面这个例子。我之前做事情喜欢养成好习惯,就是去一个网站看看人家的快递怎么抓,看看别人的返图,然后上美团买自己想吃的东西,之后再找个自己觉得不错的餐馆点个酒吃吃。其实我自己也不清楚他们有什么规则。只知道别人会每天有各种活动会发布商品信息。别人也是这样的,所以其实很多好不错的东西,大部分我都看不到。所以,我觉得可以通过那些隐藏的蛛丝马迹,找到很多我们自己想吃的东西。 查看全部

飞侠网络快递查询:国内开发者开发的chrome网页抓取神器

网页抓取工具有很多,我一般都会推荐谷歌浏览器,首先这款浏览器适用人群多,且网页抓取方便,安全,大部分情况都能满足。要说其他什么扩展之类的比如chrome扩展真的很少用到。推荐一款国内开发者开发的chrome网页抓取神器,真正把网页抓取做到了极致!飞侠网络快递查询:,除了最常用的快递查询,还支持api接口,可以实现多种接口。

我记得我前面推荐用自己的系统抓取微信公众号上面的文章是免费,是因为不想让别人免费用我的系统,但是现在有强制收费,网络里面和最后一根电缆上都是干脆利落的收费模式,我觉得不舒服,并且也不是每个免费服务都值得。所以这里给大家推荐开源的网页抓取工具,喜欢的可以去下载使用一下。另外,近期也有一个微信公众号正好在搞活动,里面带有大量的平台工具,方便大家查找,也推荐一下。

经过很长时间的思考,觉得比较好用的有dreamwingpagegenerator。不知道算不算是第一抓取网站工具,但我真的觉得很好用啊。首先一个功能就是获取历史网页。我很久没关注网页抓取了,今天刚抓了几页大家感受一下。任何网站都有往期文章/回顾,一般每篇文章末尾都会有链接让你看看近期文章。所以这些文章的历史版本可以通过dreamwing获取到。

这样我们就不用再搜各个网站的历史版本了。我们可以在搜索框输入我们需要的文章关键词,得到近期文章列表。并且通过链接,指向之前提供给我们文章的网站。这样就可以继续抓取下一个长尾关键词。fullspacewebservice(dws)就可以抓取这个。然后还有要了解的一个功能是文章关键词匹配。就是说网站上发布的文章,同一篇可能同一作者不同时间不同网站发布的内容都会获取到。

因为一般网站的维护时间是很长的,发布了一篇文章并不代表就删除掉了。我们也可以通过更新文章的时间去判断。这样就可以获取到新发布的链接,还可以解析链接内容,帮助自己抓取那些长尾文章。还有就是我觉得是非常非常方便的一个功能。就是我们可以对同一篇文章修改标题以及最后的网站地址进行变更,这样可以让之前的很多长尾网站内容进行重复抓取。

就像上面这个例子。我之前做事情喜欢养成好习惯,就是去一个网站看看人家的快递怎么抓,看看别人的返图,然后上美团买自己想吃的东西,之后再找个自己觉得不错的餐馆点个酒吃吃。其实我自己也不清楚他们有什么规则。只知道别人会每天有各种活动会发布商品信息。别人也是这样的,所以其实很多好不错的东西,大部分我都看不到。所以,我觉得可以通过那些隐藏的蛛丝马迹,找到很多我们自己想吃的东西。

【盘点】七个常用的网页数据抽取工具

网站优化 • 优采云 发表了文章 • 0 个评论 • 117 次浏览 • 2022-05-05 05:11

作为大数据从业工作者和科研人员,很多时候需要从网页中获取数据。如果不想自己编写爬虫程序,就可以使用一些专业的网页数据抽取工具来达到这一目的。接下来小编就为你盘点下七个常用的网页数据抽取工具。

1. Import.io

该工具是一款无需客户端的抓取工具,一切工作在浏览器中即可进行,操作便捷简单,爬取数据后可在可视化界面对其进行筛选。

2. Parsehub

这款工具需要下载客户端进行操作,该工具打开后类似一个浏览器,输入网址后便可进行数据提取,支持Windows、MacOS、Linux操作系统。

3. Web Scraper

这款工具是一款基于Chrome浏览器的插件,可以直接通过谷歌应用商店免费获取并安装,可以轻松抓取静态网页和js动态加载网页。

想具体了解如何使用这个工具,可以参考下面这个教程:有关webscraper的问题,看这个就够了

4. 80legs

该工具的背后是5万台计算机构成的Plura网格,功能强大,但更多的是为企业级客户服务,商业用途明显,监控能力很强,价格也较为昂贵。

5. 优采云采集器

该工具目前是国内最为成熟的网页数据采集工具,需要下载客户端,在客户端内可进行可视化数据抓取。该工具也同时具有国际版的Octoparse软件。根据采集能力,该工具分为免费版、专业版、旗舰版、私有云、企业定制版这5个版本,价格从每年0到69800元不等,免费版虽然可以免费采集,但是数据导出需要额外付费。

6. 造数

这是一款起步虽晚但有着较高爬取效率的企业向基于网页的云爬取工具,无需额外下载客户端。

7. 优采云采集器

这是国内的老牌采集器公司,商业化很早,但学习成本较高,规则制定较为复杂。收费方式为软件收费,旗舰版价格为千元左右,付费后无限制。 查看全部

【盘点】七个常用的网页数据抽取工具

作为大数据从业工作者和科研人员,很多时候需要从网页中获取数据。如果不想自己编写爬虫程序,就可以使用一些专业的网页数据抽取工具来达到这一目的。接下来小编就为你盘点下七个常用的网页数据抽取工具。

1. Import.io

该工具是一款无需客户端的抓取工具,一切工作在浏览器中即可进行,操作便捷简单,爬取数据后可在可视化界面对其进行筛选。

2. Parsehub

这款工具需要下载客户端进行操作,该工具打开后类似一个浏览器,输入网址后便可进行数据提取,支持Windows、MacOS、Linux操作系统。

3. Web Scraper

这款工具是一款基于Chrome浏览器的插件,可以直接通过谷歌应用商店免费获取并安装,可以轻松抓取静态网页和js动态加载网页。

想具体了解如何使用这个工具,可以参考下面这个教程:有关webscraper的问题,看这个就够了

4. 80legs

该工具的背后是5万台计算机构成的Plura网格,功能强大,但更多的是为企业级客户服务,商业用途明显,监控能力很强,价格也较为昂贵。

5. 优采云采集器

该工具目前是国内最为成熟的网页数据采集工具,需要下载客户端,在客户端内可进行可视化数据抓取。该工具也同时具有国际版的Octoparse软件。根据采集能力,该工具分为免费版、专业版、旗舰版、私有云、企业定制版这5个版本,价格从每年0到69800元不等,免费版虽然可以免费采集,但是数据导出需要额外付费。

6. 造数

这是一款起步虽晚但有着较高爬取效率的企业向基于网页的云爬取工具,无需额外下载客户端。

7. 优采云采集器

这是国内的老牌采集器公司,商业化很早,但学习成本较高,规则制定较为复杂。收费方式为软件收费,旗舰版价格为千元左右,付费后无限制。

关于制作网页导航这件事

网站优化 • 优采云 发表了文章 • 0 个评论 • 72 次浏览 • 2022-04-30 16:00

小唐学化学

过去一周由于疫情防控的需要,校园进行了封楼管理。利用在宿舍的空余时间,我收集汇总了自己在过去几年经常用到的网页。主要涵盖科研论文获取、论文写作、常用软件下载以及部分能够提高工作效率的小工具,网页导航还在进一步更新中。下面主要介绍一下这些网址的作用:

小工具

这个部分主要是一些能够提高工作效率的小工具。I Love Pdf 是一个可以在线编辑PDF文件的网页,包括但不限于PDF合并、PDF分割、PDF转jpg等等。在线抠图可以快速抓取图片中的主体内容,将日常实验室实验照片进行扣取,用于PPT汇报让人感觉更加正式。b站下载可以复制b站上面的网页地址进行直接下载。脚本获取主要是针对谷歌浏览器、Edge浏览器的脚本下载。

文献获取

这个部分主要是对日常使用到的文献搜集数据库进行整合。其中包括最常用的Web of Science、中国知网、万方等,此外还添加了DOI一键获取论文、SCI-hub等大家耳熟能详的论文下载方式。

论文写作

这个部分主要包括了论文写作过程中的翻译、语法检测、降重与改写。前面几个翻译工具大家应该是最常用到的,其中我认为DeepL和知网翻译相对符合论文写作或者阅读的思维。写作过程中,对于需要缩写的术语或专业名词可以参考术语在线等工具。后面还有一些语法检查、降重改写的工具。可以先结合这些工具给的建议进行选择性采纳,最后根据自己的理解做最后的修改,之前参加美赛的时候,大致思路就是先写英式中文,把语句尽量写短,写精炼。然后用翻译软件来回的中译英、英译中检查大致意思有没有翻译错误,接着使用语法检测软件来回修改几次,查重降重,最后提交。SCI结构示范里面给了很多引言、方法、结论的模板,可以适当参考。

其他

后面还有三个部分主要是我们课题组用的相对多一些。权威数据获取里面主要是一些晶体数据获取的网址,例如CCDC或者COD等。软件安装的话为了节省时间以及方便日后维护,直接搭乘的是几个公众号平台的便车,一键直达。里面有绝大部分化学类研究生需要用到的软件,课题组常用分组里面是一些校内的网址,例如仪器预约、网上报销等等。欢迎大家体验。网址如下,微信平台打不开,需要复制到浏览器或者电脑网页打开。

小唐学化学:

查看全部

关于制作网页导航这件事

小唐学化学

过去一周由于疫情防控的需要,校园进行了封楼管理。利用在宿舍的空余时间,我收集汇总了自己在过去几年经常用到的网页。主要涵盖科研论文获取、论文写作、常用软件下载以及部分能够提高工作效率的小工具,网页导航还在进一步更新中。下面主要介绍一下这些网址的作用:

小工具

这个部分主要是一些能够提高工作效率的小工具。I Love Pdf 是一个可以在线编辑PDF文件的网页,包括但不限于PDF合并、PDF分割、PDF转jpg等等。在线抠图可以快速抓取图片中的主体内容,将日常实验室实验照片进行扣取,用于PPT汇报让人感觉更加正式。b站下载可以复制b站上面的网页地址进行直接下载。脚本获取主要是针对谷歌浏览器、Edge浏览器的脚本下载。

文献获取

这个部分主要是对日常使用到的文献搜集数据库进行整合。其中包括最常用的Web of Science、中国知网、万方等,此外还添加了DOI一键获取论文、SCI-hub等大家耳熟能详的论文下载方式。

论文写作

这个部分主要包括了论文写作过程中的翻译、语法检测、降重与改写。前面几个翻译工具大家应该是最常用到的,其中我认为DeepL和知网翻译相对符合论文写作或者阅读的思维。写作过程中,对于需要缩写的术语或专业名词可以参考术语在线等工具。后面还有一些语法检查、降重改写的工具。可以先结合这些工具给的建议进行选择性采纳,最后根据自己的理解做最后的修改,之前参加美赛的时候,大致思路就是先写英式中文,把语句尽量写短,写精炼。然后用翻译软件来回的中译英、英译中检查大致意思有没有翻译错误,接着使用语法检测软件来回修改几次,查重降重,最后提交。SCI结构示范里面给了很多引言、方法、结论的模板,可以适当参考。

其他

后面还有三个部分主要是我们课题组用的相对多一些。权威数据获取里面主要是一些晶体数据获取的网址,例如CCDC或者COD等。软件安装的话为了节省时间以及方便日后维护,直接搭乘的是几个公众号平台的便车,一键直达。里面有绝大部分化学类研究生需要用到的软件,课题组常用分组里面是一些校内的网址,例如仪器预约、网上报销等等。欢迎大家体验。网址如下,微信平台打不开,需要复制到浏览器或者电脑网页打开。

小唐学化学:

安利学习软件!商院学生必看!

网站优化 • 优采云 发表了文章 • 0 个评论 • 83 次浏览 • 2022-04-30 15:31

目前,人工智能、互联网、大数据、云计算等技术在财会领域的应用越来越广泛,这也必要求会计人员懂技术。而对于财会类专业学生而言,我们首先需要熟练掌握一些基本的软件,比如办公软件、数据统计与分析软件、云笔记、思维导图、制图软件等,通过使用各类软件以提高学习与工作的效率!

01基本办公软件

Word、Excel、PPT

Microsoft Office系列或者WPS系列中的Word、Excel、PPT,对于财会类专业的学生和会计工作人员而言,都是必不可少的基本办公软件。

02数据统计与分析软件

SPSSStatistica、Eviews、

Matlab、Stata、SAS、R、Python

(图源:网络)

目前,Python是一款最热、功能齐全的软件了,强烈推荐!特别是对编程语言有一定基础的同学更得心应手。不过,SPSS Statistica、Eviews、Matlab、Stata、SAS、R、Python这几款软件也是各有特色的!

对于编程知识薄弱的同学而言,只需要基础统计学知识,就可以操作SPSS。SPSS具有非常强的统计分析功能,如相关分析、回归分析、聚类分析、生存分析等;适合于为计量分析做事前处理,如多元变量降维,数据收集、整合、假设检验等等工作。在回归分析方面,spss能力相对于其他软件而言,不够全面和方便。在此,向大家推荐SPSS 22以上版本。

Eviews是专门为大型机构开发的、用以处理时间序列数据的时间序列软件包的新版本。

Matlab主要用于算法开发、数据可视化、数据分析以及数值计算的高级技术计算语言和交互式环境,它具有友好的用户界面及接近数学表达式的自然化语言,使学者易于学习和掌握;具有完备的图形处理功能,实现计算结果和编程的可视化。但是,Matlab的速度有些慢。

SAS提供了从基本统计数的计算到各种试验设计的方差分析,相关回归分析以及多变数分析的多种统计分析过程,几乎囊括了所有最新分析方法,其分析技术先进,可靠;使用简便,操作灵活;其编程语句简洁,短小,通常只需很小的几句语句即可完成一些复杂的运算,得到满意的结果。

Stata其统计分析能力超过了SPSS,在许多方面也超过了SAS,由于Stata在分析时是将数据全部读入内存,在计算全部完成后才和磁盘交换数据,因此计算速度极快。

一般来说, SAS的运算速度要比SPSS至少快一个数量级,而Stata的某些模块和执行同样功能的SAS模块比,其速度又比SAS快将近一个数量级!

R语言属于GNU系统的一个自由、免费、源代码开放的软件,它是一个用于统计计算和统计制图的优秀工具,制图具有印刷的素质,也可加入数学符号;具有一套源自S语言,完善、简单、有效的编程语言(包括条件、循环、自定义函数、输入输出功能)。

Python为什么如此热门,除了有很强的数据统计与分析的功能,还具有Web 和 Internet开发,网络爬虫等功能。

首先,众多开源的科学计算库都提供了Python的调用接口;用户可以在任何计算机上免费安装Python及其绝大多数扩展库。

其次,与Matlab相比,Python是一门更易学、更严谨的程序设计语言。它能让用户编写出更易读、易维护的代码。

最后,Python有着丰富的扩展库,比如scrapy 爬虫框架、sklearn 机器学习、tensorflow 深度学习,可以轻易完成各种高级任务,开发者可以用Python实现完整应用程序所需的各种功能。

03云笔记

为知笔记、有道云笔记

(图源:网络)

云笔记方便你随时收录与整理文件与网页内容;配合思维导图软件使用,效果更好。为知笔记、有道云笔记通常具有这些优点:

分类整理笔记,高效管理个人知识,快速搜索,分类查找,安全备份云端笔记,存储永不丢失的珍贵资料。

文件同步自动完成——自动同步,无需拷贝下载;支持图片及文档类附件,无限增长的大存储空间。

随时随地记录一切趣事和想法:轻松与电脑双向同步。

精彩网页一键保存——一键保存网页中精彩图文,再也不会遗漏。

手写输入——用手指直接在屏幕上输入,保留手写原笔迹;

涂鸦——轻松、有趣的随手涂鸦,绘制您所想。

04思维导图

Mind Manager、X Mind、

MindMaster、Mind line

(图源:网络)

无论是学习还是工作中,比如写一篇论文、做一次演讲,我们经常需要整理自己的思路,那么思维导图软件是帮助我们理清思路、头脑风暴、抓住灵感最好的工具了;思维导图在搭建知识构架方面也是非常有用的。

Mind Manager是行业中最专业、逼格最高的,但是目前网上你几乎找不到免费版本;X Mind则是免费的,绝对够用;国产的亿图思维导图软件MindMaster也可以也免费。

Mind Manager、X Mind、MindMaster、Mind line这几款的功能很接近,特别推荐X Mind,X Mind 提供各种结构图,比如鱼骨图、矩阵图、时间轴、组织结构图等来帮你更好地理清复杂的想法和事项。这些多种视觉化的思维呈现方式让你能进行深度的对比分析,更直观地进行里程碑的记录和事项的安排。

05文献阅读器

PDF、超星阅读器、CAJ阅读器

有人喜欢Adobe Acrobat Reader,有人采用福昕pdf阅读器,但注意的是做科研的,当然要用专业版本的。

其中,Adobe AcrobatReader要专业版本,福昕要福昕pdf高级编辑器,这些版本的软件功能才会全面,解决pdf的常见需求,比如标记功能、pdf页面管理功能(把图片、word、excel等文件自由地组合到原有pdf文件中去)。

此外,学校往往会购买超星和知网数据库,而超星的电子书籍需要下载超星阅读器才可以看,知网的部分文献,尤其是硕博士论文,需要用官方的CAJ阅读器查看。

06文献管理器

NoteExpress、Mendeley、

E-study、Endnote

NoteExpress是国内专业的文献检索与管理系统,其核心功能是帮助读者高效利用文献,收集并管理得到的文献元数据和全文,帮助科研工作者提高工作效率,此款是比较推荐的!

Mendeley是一款免费的文献管理软件,有一键抓取网页上的文本添加到个人library中的功能,安装插件后还可以编辑文本。

E-study是中国知网的一个附属功能软件,使用方便,能同步下载知网上的论文。

Endnote是汤森路透的老牌文献管理软件,目前最新版是Endnote X9.2,Endnote的文献去重复功能比较突出,但有时候中文支持也不太好。

07科研作图软件

Origin、SigmaPlot、PS、Matlab、R

Origin是国际出版界公认的标准数据处理与科学绘图软件,是一款定位于基础和专业之间的作图软件。它的界面简单,操作也容易入门和掌握。但是,相比于Excel作图,Origin又为我们提供了非常多样的数据图表制作样式以及自定义编辑。

SigmaPlot的功能与Origin非常类似,但是在操作的易用性上会更好,某些样式的图导出后比Origin效果要好,可以与Origin互补。

Adobe photoshop(PS)这个很多时候用来组图,添加点标志,其应用广泛,业余时可以学习ps教程。

此外,Matlab、R也有很强大的作图功能,通过编程实现。比如R语言中也可以实现气泡图、箱线图、专业曲线图的绘制。

08流程图

Visio、ProcessOn

(图源:网络)

在一些论文里面,需要画流程图或者技术路线图,图形能直观体现论文框架或者某个思路,虽然Word里面可制作简单的流程图,但是没有专门的流程图制作软件方便,而且Visio等里面更多的多种功能。

Office Visio 是office软件系列中的负责绘制流程图和示意图的软件,是一款对复杂信息、系统和流程进行可视化处理、分析和交流的软件;具有专业外观的 Office Visio 图表。

ProcessOn是一个在线作图工具的聚合平台,它可以在线画流程图、思维导图、UI原型图、UML、网络拓扑图、组织结构图等等。

09翻译工具

google翻译、CNKI翻译助手、有道翻译

翻译工具的功能基本差不多,其中,CNKI翻译助手中呈现出的例句与词汇均出于学术期刊,而且大多可以追索到对应文献原文;可以帮助搜索到一些专业术语,了解常规表达与用法,顺带着还可以看看国内外相关领域的文献。

小伙伴们对财会证书有备考需求的话,可以关注抖音号!抖主不定时上传CPA方向班老师们的课程,供大家在休闲的时候学习观看!

扫描上方二维码,添加助教老师微信!领取学习礼包!添加时备注:专业+姓名!想要了解注会的报考条件、考试科目、就业方向、学习方法等,记得跟教务老师申请咨询注会的时间哦! 查看全部

安利学习软件!商院学生必看!

目前,人工智能、互联网、大数据、云计算等技术在财会领域的应用越来越广泛,这也必要求会计人员懂技术。而对于财会类专业学生而言,我们首先需要熟练掌握一些基本的软件,比如办公软件、数据统计与分析软件、云笔记、思维导图、制图软件等,通过使用各类软件以提高学习与工作的效率!

01基本办公软件

Word、Excel、PPT

Microsoft Office系列或者WPS系列中的Word、Excel、PPT,对于财会类专业的学生和会计工作人员而言,都是必不可少的基本办公软件。

02数据统计与分析软件

SPSSStatistica、Eviews、

Matlab、Stata、SAS、R、Python

(图源:网络)

目前,Python是一款最热、功能齐全的软件了,强烈推荐!特别是对编程语言有一定基础的同学更得心应手。不过,SPSS Statistica、Eviews、Matlab、Stata、SAS、R、Python这几款软件也是各有特色的!

对于编程知识薄弱的同学而言,只需要基础统计学知识,就可以操作SPSS。SPSS具有非常强的统计分析功能,如相关分析、回归分析、聚类分析、生存分析等;适合于为计量分析做事前处理,如多元变量降维,数据收集、整合、假设检验等等工作。在回归分析方面,spss能力相对于其他软件而言,不够全面和方便。在此,向大家推荐SPSS 22以上版本。

Eviews是专门为大型机构开发的、用以处理时间序列数据的时间序列软件包的新版本。

Matlab主要用于算法开发、数据可视化、数据分析以及数值计算的高级技术计算语言和交互式环境,它具有友好的用户界面及接近数学表达式的自然化语言,使学者易于学习和掌握;具有完备的图形处理功能,实现计算结果和编程的可视化。但是,Matlab的速度有些慢。

SAS提供了从基本统计数的计算到各种试验设计的方差分析,相关回归分析以及多变数分析的多种统计分析过程,几乎囊括了所有最新分析方法,其分析技术先进,可靠;使用简便,操作灵活;其编程语句简洁,短小,通常只需很小的几句语句即可完成一些复杂的运算,得到满意的结果。

Stata其统计分析能力超过了SPSS,在许多方面也超过了SAS,由于Stata在分析时是将数据全部读入内存,在计算全部完成后才和磁盘交换数据,因此计算速度极快。

一般来说, SAS的运算速度要比SPSS至少快一个数量级,而Stata的某些模块和执行同样功能的SAS模块比,其速度又比SAS快将近一个数量级!

R语言属于GNU系统的一个自由、免费、源代码开放的软件,它是一个用于统计计算和统计制图的优秀工具,制图具有印刷的素质,也可加入数学符号;具有一套源自S语言,完善、简单、有效的编程语言(包括条件、循环、自定义函数、输入输出功能)。

Python为什么如此热门,除了有很强的数据统计与分析的功能,还具有Web 和 Internet开发,网络爬虫等功能。

首先,众多开源的科学计算库都提供了Python的调用接口;用户可以在任何计算机上免费安装Python及其绝大多数扩展库。

其次,与Matlab相比,Python是一门更易学、更严谨的程序设计语言。它能让用户编写出更易读、易维护的代码。

最后,Python有着丰富的扩展库,比如scrapy 爬虫框架、sklearn 机器学习、tensorflow 深度学习,可以轻易完成各种高级任务,开发者可以用Python实现完整应用程序所需的各种功能。

03云笔记

为知笔记、有道云笔记

(图源:网络)

云笔记方便你随时收录与整理文件与网页内容;配合思维导图软件使用,效果更好。为知笔记、有道云笔记通常具有这些优点:

分类整理笔记,高效管理个人知识,快速搜索,分类查找,安全备份云端笔记,存储永不丢失的珍贵资料。

文件同步自动完成——自动同步,无需拷贝下载;支持图片及文档类附件,无限增长的大存储空间。

随时随地记录一切趣事和想法:轻松与电脑双向同步。

精彩网页一键保存——一键保存网页中精彩图文,再也不会遗漏。

手写输入——用手指直接在屏幕上输入,保留手写原笔迹;

涂鸦——轻松、有趣的随手涂鸦,绘制您所想。

04思维导图

Mind Manager、X Mind、

MindMaster、Mind line

(图源:网络)

无论是学习还是工作中,比如写一篇论文、做一次演讲,我们经常需要整理自己的思路,那么思维导图软件是帮助我们理清思路、头脑风暴、抓住灵感最好的工具了;思维导图在搭建知识构架方面也是非常有用的。

Mind Manager是行业中最专业、逼格最高的,但是目前网上你几乎找不到免费版本;X Mind则是免费的,绝对够用;国产的亿图思维导图软件MindMaster也可以也免费。

Mind Manager、X Mind、MindMaster、Mind line这几款的功能很接近,特别推荐X Mind,X Mind 提供各种结构图,比如鱼骨图、矩阵图、时间轴、组织结构图等来帮你更好地理清复杂的想法和事项。这些多种视觉化的思维呈现方式让你能进行深度的对比分析,更直观地进行里程碑的记录和事项的安排。

05文献阅读器

PDF、超星阅读器、CAJ阅读器

有人喜欢Adobe Acrobat Reader,有人采用福昕pdf阅读器,但注意的是做科研的,当然要用专业版本的。

其中,Adobe AcrobatReader要专业版本,福昕要福昕pdf高级编辑器,这些版本的软件功能才会全面,解决pdf的常见需求,比如标记功能、pdf页面管理功能(把图片、word、excel等文件自由地组合到原有pdf文件中去)。

此外,学校往往会购买超星和知网数据库,而超星的电子书籍需要下载超星阅读器才可以看,知网的部分文献,尤其是硕博士论文,需要用官方的CAJ阅读器查看。

06文献管理器

NoteExpress、Mendeley、

E-study、Endnote

NoteExpress是国内专业的文献检索与管理系统,其核心功能是帮助读者高效利用文献,收集并管理得到的文献元数据和全文,帮助科研工作者提高工作效率,此款是比较推荐的!

Mendeley是一款免费的文献管理软件,有一键抓取网页上的文本添加到个人library中的功能,安装插件后还可以编辑文本。

E-study是中国知网的一个附属功能软件,使用方便,能同步下载知网上的论文。

Endnote是汤森路透的老牌文献管理软件,目前最新版是Endnote X9.2,Endnote的文献去重复功能比较突出,但有时候中文支持也不太好。

07科研作图软件

Origin、SigmaPlot、PS、Matlab、R

Origin是国际出版界公认的标准数据处理与科学绘图软件,是一款定位于基础和专业之间的作图软件。它的界面简单,操作也容易入门和掌握。但是,相比于Excel作图,Origin又为我们提供了非常多样的数据图表制作样式以及自定义编辑。

SigmaPlot的功能与Origin非常类似,但是在操作的易用性上会更好,某些样式的图导出后比Origin效果要好,可以与Origin互补。

Adobe photoshop(PS)这个很多时候用来组图,添加点标志,其应用广泛,业余时可以学习ps教程。

此外,Matlab、R也有很强大的作图功能,通过编程实现。比如R语言中也可以实现气泡图、箱线图、专业曲线图的绘制。

08流程图

Visio、ProcessOn

(图源:网络)

在一些论文里面,需要画流程图或者技术路线图,图形能直观体现论文框架或者某个思路,虽然Word里面可制作简单的流程图,但是没有专门的流程图制作软件方便,而且Visio等里面更多的多种功能。

Office Visio 是office软件系列中的负责绘制流程图和示意图的软件,是一款对复杂信息、系统和流程进行可视化处理、分析和交流的软件;具有专业外观的 Office Visio 图表。

ProcessOn是一个在线作图工具的聚合平台,它可以在线画流程图、思维导图、UI原型图、UML、网络拓扑图、组织结构图等等。

09翻译工具

google翻译、CNKI翻译助手、有道翻译

翻译工具的功能基本差不多,其中,CNKI翻译助手中呈现出的例句与词汇均出于学术期刊,而且大多可以追索到对应文献原文;可以帮助搜索到一些专业术语,了解常规表达与用法,顺带着还可以看看国内外相关领域的文献。

小伙伴们对财会证书有备考需求的话,可以关注抖音号!抖主不定时上传CPA方向班老师们的课程,供大家在休闲的时候学习观看!

扫描上方二维码,添加助教老师微信!领取学习礼包!添加时备注:专业+姓名!想要了解注会的报考条件、考试科目、就业方向、学习方法等,记得跟教务老师申请咨询注会的时间哦!

20款适用于网络安全专家的免费取证调查工具

网站优化 • 优采云 发表了文章 • 0 个评论 • 160 次浏览 • 2022-04-30 06:10

一、Autopsy

()

Autopsy是一个基于 GUI 的开源数字取证程序,可有效分析硬盘驱动器和智能手机。全球数以千计的用户使用 Autospy 来调查计算机上发生的事情。

它被公司审查员、军队调查广泛使用,其中一些功能也是如此。

它可以以 HTML、XLS 文件格式生成的大量报告。

二、Encrypted Disk Detector

()

Encrypted Disk Detector有助于检查加密的物理驱动器。它支持 TrueCrypt、PGP、BitLocker、Safeboot 加密卷。

三、Wireshark

()

Wireshark是一种网络捕获和分析工具,用于查看网络中发生的情况。Wireshark 可以方便地调查与网络相关的事件。

四、Magnet RAM capture

()

您可以使用Magnet RAM capture来捕获计算机的物理内存并分析内存中的伪影。

它支持Windows操作系统。

五、Network Miner

()

适用于 Windows、Linux 和 MAC OS X 的有趣网络取证分析器,可通过数据包嗅探或 PCAP 文件检测操作系统、主机名、会话和开放端口。Network Miner在直观的用户界面中提供提取的工件。

六、NMAP

()

Nmap(“网络映射器”)是一个免费和开源的用于网络发现和安全审计的实用程序。许多系统和网络管理员还发现它对网络清单、管理服务升级计划以及监控主机或服务正常运行时间等任务很有用。Nmap 以新颖的方式使用原始 IP 数据包来确定网络上可用的主机、这些主机提供的服务(应用程序名称和版本)、它们运行的操作系统(和操作系统版本)、数据包过滤器/防火墙的类型正在使用中,以及其他数十种特性。它旨在快速扫描大型网络,但对单个主机也能正常工作。Nmap 在所有主要的计算机操作系统上运行,官方二进制包可用于 Linux、Windows 和 Mac OS X。除了经典的命令行 Nmap 可执行文件,Zenmap),一个灵活的数据传输、重定向和调试工具(Ncat),一个用于比较扫描结果的实用程序(Ndiff),以及一个数据包生成和响应分析工具(Nping)。

七、RAM Capturer

()

Belkasoft 的 RAM Capturer是一个免费工具,用于从计算机的易失性内存中转储数据。它与 Windows 操作系统兼容。内存转储可能包含加密卷的密码和网络邮件和社交网络服务的登录凭据。

八、Forensic Investigator

()

如果您使用的是 Splunk,那么Forensic Investigator将是一个方便的工具。这是一个 Splunk 应用程序,结合了许多工具。

九、FAW

()

FAW(Forensics Acquisition of Websites)是获取网页进行取证调查,具有以下特点。

十、HashMyFiles

()

HashMyFiles将帮助您计算 MD5 和 SHA1 哈希值。它适用于几乎所有最新的 Windows 操作系统。

十一、Response

()

Response是一个 Windows 应用程序,用于收集事件响应和安全参与的系统信息。您可以在 CRConvert 的帮助下以 XML、CSV、TSV 或 HTML 格式查看结果。它运行在 32 位或 64 位以上的 Windows XP 上。

Crowd Strike 还有其他一些有用的调查工具。

十二、NFI Defraser

()

Defraser取证工具可以帮助您检测数据流中的全部和部分多媒体文件。

十三、ExifTool

()

ExifTool可帮助您读取、写入和编辑多种文件类型的元信息。它可以读取 EXIF、GPS、IPTC、XMP、JFIF、GeoTIFF、Photoshop IRB、FlashPix 等。

十四、Toolsley

()

Toolsley获得了十多个有用的工具进行调查。

十五、SIFT

(#overview)

SIFT(SANS 调查取证工具包)工作站作为 Ubuntu 14.04 免费提供。SIFT 是您需要的一套取证工具,也是最受欢迎的开源情报平台之一。

十六、Dumpzilla

()

从 Firefox、Iceweasel 和 Seamonkey 浏览器中提取所有令人兴奋的信息,以便使用Dumpzilla进行分析。

十七、ForensicUserInfo

()

使用ForensicUserInfo提取以下信息。

十八、KaliLinux

()

Kali Linux是最流行的安全和渗透测试操作系统之一,但它也具有取证能力。有超过 100 种工具,所以我相信您会找到适合您需要的一种。

十九、PALADIN

()

PALADIN取证套件——世界上最著名的 Linux 取证套件是基于 Ubuntu 的修改版 Linux 发行版,提供 32 位和 64 位版本。

PALADIN拥有29 个类别下的 100 多种工具,几乎可以满足您调查事件所需的一切。Autospy 包含在最新版本 - Paladin 6 中。

二十、The Sleuth Kit

()

Sleuth Kit是一组命令行工具,用于调查和分析卷和文件系统以查找证据。 查看全部

20款适用于网络安全专家的免费取证调查工具

一、Autopsy

()

Autopsy是一个基于 GUI 的开源数字取证程序,可有效分析硬盘驱动器和智能手机。全球数以千计的用户使用 Autospy 来调查计算机上发生的事情。

它被公司审查员、军队调查广泛使用,其中一些功能也是如此。

它可以以 HTML、XLS 文件格式生成的大量报告。

二、Encrypted Disk Detector

()

Encrypted Disk Detector有助于检查加密的物理驱动器。它支持 TrueCrypt、PGP、BitLocker、Safeboot 加密卷。

三、Wireshark

()

Wireshark是一种网络捕获和分析工具,用于查看网络中发生的情况。Wireshark 可以方便地调查与网络相关的事件。

四、Magnet RAM capture

()

您可以使用Magnet RAM capture来捕获计算机的物理内存并分析内存中的伪影。

它支持Windows操作系统。

五、Network Miner

()

适用于 Windows、Linux 和 MAC OS X 的有趣网络取证分析器,可通过数据包嗅探或 PCAP 文件检测操作系统、主机名、会话和开放端口。Network Miner在直观的用户界面中提供提取的工件。

六、NMAP

()

Nmap(“网络映射器”)是一个免费和开源的用于网络发现和安全审计的实用程序。许多系统和网络管理员还发现它对网络清单、管理服务升级计划以及监控主机或服务正常运行时间等任务很有用。Nmap 以新颖的方式使用原始 IP 数据包来确定网络上可用的主机、这些主机提供的服务(应用程序名称和版本)、它们运行的操作系统(和操作系统版本)、数据包过滤器/防火墙的类型正在使用中,以及其他数十种特性。它旨在快速扫描大型网络,但对单个主机也能正常工作。Nmap 在所有主要的计算机操作系统上运行,官方二进制包可用于 Linux、Windows 和 Mac OS X。除了经典的命令行 Nmap 可执行文件,Zenmap),一个灵活的数据传输、重定向和调试工具(Ncat),一个用于比较扫描结果的实用程序(Ndiff),以及一个数据包生成和响应分析工具(Nping)。

七、RAM Capturer

()

Belkasoft 的 RAM Capturer是一个免费工具,用于从计算机的易失性内存中转储数据。它与 Windows 操作系统兼容。内存转储可能包含加密卷的密码和网络邮件和社交网络服务的登录凭据。

八、Forensic Investigator

()

如果您使用的是 Splunk,那么Forensic Investigator将是一个方便的工具。这是一个 Splunk 应用程序,结合了许多工具。

九、FAW

()

FAW(Forensics Acquisition of Websites)是获取网页进行取证调查,具有以下特点。

十、HashMyFiles

()

HashMyFiles将帮助您计算 MD5 和 SHA1 哈希值。它适用于几乎所有最新的 Windows 操作系统。

十一、Response

()

Response是一个 Windows 应用程序,用于收集事件响应和安全参与的系统信息。您可以在 CRConvert 的帮助下以 XML、CSV、TSV 或 HTML 格式查看结果。它运行在 32 位或 64 位以上的 Windows XP 上。

Crowd Strike 还有其他一些有用的调查工具。

十二、NFI Defraser

()

Defraser取证工具可以帮助您检测数据流中的全部和部分多媒体文件。

十三、ExifTool

()

ExifTool可帮助您读取、写入和编辑多种文件类型的元信息。它可以读取 EXIF、GPS、IPTC、XMP、JFIF、GeoTIFF、Photoshop IRB、FlashPix 等。

十四、Toolsley

()

Toolsley获得了十多个有用的工具进行调查。

十五、SIFT

(#overview)

SIFT(SANS 调查取证工具包)工作站作为 Ubuntu 14.04 免费提供。SIFT 是您需要的一套取证工具,也是最受欢迎的开源情报平台之一。

十六、Dumpzilla

()

从 Firefox、Iceweasel 和 Seamonkey 浏览器中提取所有令人兴奋的信息,以便使用Dumpzilla进行分析。

十七、ForensicUserInfo

()

使用ForensicUserInfo提取以下信息。

十八、KaliLinux

()

Kali Linux是最流行的安全和渗透测试操作系统之一,但它也具有取证能力。有超过 100 种工具,所以我相信您会找到适合您需要的一种。

十九、PALADIN

()

PALADIN取证套件——世界上最著名的 Linux 取证套件是基于 Ubuntu 的修改版 Linux 发行版,提供 32 位和 64 位版本。

PALADIN拥有29 个类别下的 100 多种工具,几乎可以满足您调查事件所需的一切。Autospy 包含在最新版本 - Paladin 6 中。

二十、The Sleuth Kit

()

Sleuth Kit是一组命令行工具,用于调查和分析卷和文件系统以查找证据。

网页抓取技术,firebug,,代码查看器安装正式版

网站优化 • 优采云 发表了文章 • 0 个评论 • 59 次浏览 • 2022-04-29 23:00

网页抓取工具有很多,

1)网页一键抓取-fireshot

2)网页一键爬取-urllib2

3)爬虫主要做ip抓取,一般都会带cookie最好将cookie设置好。具体方法我在另一个问题答案中已经有说到:网页抓取技术,

firebug,appium,代码查看器,正则表达式,下面2个也可以,不过要安装正式版(大家搜索okhttp,这个是okhttp2的api封装,带给你android的api以及做移动端的优化)://android学习中的重要pieholic//当我们在请求一个你自己写的接口时候需要查看请求的参数,最常用的方法是下面2个:for(jsonobjectjsonobject:jsonobject){if(stringtoken==jsonobject。

tostring()。equals("1")){return;}try{this。obj[this。token]=jsonobject。getjsonobject(jsonobject。class,jsonobject。string())。getjsonobjectstring();}catch(throwablee){thrownewthrowable("请求string时候使用jsonobject");}}//koajs/http。js文件://。

curl1.和firebug一样都可以抓取图片链接firebug抓取图片;代码可以去github上找,

geekpie/okhttp:buildthewebexpress,functionally。geekpie/urllib2:apythonurlfieldlibraryforlibrarybuilding,theyshouldhaveasimpleindexofjsonfieldswithheadersandnotneededtoimportimages。 查看全部

网页抓取技术,firebug,,代码查看器安装正式版

网页抓取工具有很多,

1)网页一键抓取-fireshot

2)网页一键爬取-urllib2

3)爬虫主要做ip抓取,一般都会带cookie最好将cookie设置好。具体方法我在另一个问题答案中已经有说到:网页抓取技术,

firebug,appium,代码查看器,正则表达式,下面2个也可以,不过要安装正式版(大家搜索okhttp,这个是okhttp2的api封装,带给你android的api以及做移动端的优化)://android学习中的重要pieholic//当我们在请求一个你自己写的接口时候需要查看请求的参数,最常用的方法是下面2个:for(jsonobjectjsonobject:jsonobject){if(stringtoken==jsonobject。

tostring()。equals("1")){return;}try{this。obj[this。token]=jsonobject。getjsonobject(jsonobject。class,jsonobject。string())。getjsonobjectstring();}catch(throwablee){thrownewthrowable("请求string时候使用jsonobject");}}//koajs/http。js文件://。

curl1.和firebug一样都可以抓取图片链接firebug抓取图片;代码可以去github上找,

geekpie/okhttp:buildthewebexpress,functionally。geekpie/urllib2:apythonurlfieldlibraryforlibrarybuilding,theyshouldhaveasimpleindexofjsonfieldswithheadersandnotneededtoimportimages。

网页抓取工具(优采云采集器网址:集搜客没有内容采集规则解析(图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 102 次浏览 • 2022-04-19 07:26

优采云采集器

网址:

优采云采集器 是一个 13 岁的 采集 工具。它不仅可以做爬虫,还可以做数据清洗、分析、挖掘和可视化。数据源适用于绝大多数网页,通过采集规则可以抓取网页上可以看到的内容。

优采云

网址:

优采云 也是一个知名的采集 工具,它有两个版本,一个免费的采集 模板和一个云采集(付费)。

免费的采集模板其实就是内容采集规则,包括电商、生活服务、社交媒体和论坛网站都可以是采集,使用起来很方便。当然你也可以自定义任务。

那么什么是云采集?也就是配置好采集任务后,就可以将采集的任务交给优采云的云端。优采云一共有5000台服务器,通过云端多节点并发采集,采集速度比本地采集快很多。另外,可以自动切换多个IP,避免IP阻塞影响采集。

在很多情况下,自动IP切换和云采集是自动化采集的关键。

吉苏克

该工具具有完全可视化操作,无需编程。整个采集过程也是所见即所得,抓拍结果信息、错误信息等都在软件中体现出来。与优采云相比,Jisouke没有进程的概念。用户只需要关注抓取哪些数据,流程细节完全由吉索客处理。

即搜客的缺点是不具备云采集的功能,所有爬虫都运行在用户自己的电脑上。

更新时间:2019-12-31 查看全部

网页抓取工具(优采云采集器网址:集搜客没有内容采集规则解析(图))

优采云采集器

网址:

优采云采集器 是一个 13 岁的 采集 工具。它不仅可以做爬虫,还可以做数据清洗、分析、挖掘和可视化。数据源适用于绝大多数网页,通过采集规则可以抓取网页上可以看到的内容。

优采云

网址:

优采云 也是一个知名的采集 工具,它有两个版本,一个免费的采集 模板和一个云采集(付费)。

免费的采集模板其实就是内容采集规则,包括电商、生活服务、社交媒体和论坛网站都可以是采集,使用起来很方便。当然你也可以自定义任务。

那么什么是云采集?也就是配置好采集任务后,就可以将采集的任务交给优采云的云端。优采云一共有5000台服务器,通过云端多节点并发采集,采集速度比本地采集快很多。另外,可以自动切换多个IP,避免IP阻塞影响采集。

在很多情况下,自动IP切换和云采集是自动化采集的关键。

吉苏克

该工具具有完全可视化操作,无需编程。整个采集过程也是所见即所得,抓拍结果信息、错误信息等都在软件中体现出来。与优采云相比,Jisouke没有进程的概念。用户只需要关注抓取哪些数据,流程细节完全由吉索客处理。

即搜客的缺点是不具备云采集的功能,所有爬虫都运行在用户自己的电脑上。

更新时间:2019-12-31

网页抓取工具(这里介绍2个不错的爬虫软件—Excel和优采云)

网站优化 • 优采云 发表了文章 • 0 个评论 • 233 次浏览 • 2022-04-16 11:28

这里有两个不错的爬虫软件——Excel 和 优采云。对于常规的静态网页,您可以使用 Excel 对其进行爬网。对于稍微复杂一点的网页,可以使用优采云来爬取。下面先简单介绍一下这两款软件,主要内容如下:

Excel

大多数人都应该使用 Excel。除了日常的数据统计处理,还可以爬取网页数据。让我简单介绍一下爬取过程。主要步骤如下。这里以爬取 PM2.5 数据为例:

1.首先新建一个Excel文件并打开,点击菜单栏中的“数据”->“来自网站”,如下:

2.接下来在弹出的“新建Web查询”对话框中输入需要爬取的URL,点击“Go”,就会加载我们需要爬取的网页,如下: