网站调用新浪微博内容

网站调用新浪微博内容(OAuth2.0协议授权流程查看/access_token获取)

网站优化 • 优采云 发表了文章 • 0 个评论 • 106 次浏览 • 2021-11-08 17:12

一、OAuth2.0概览

大多数 API 访问,例如发布微博、获取私人消息和关注,都需要用户身份。目前新浪微博开放平台用户身份认证包括OAuth2.0和Basic Auth(仅用于应用开发Debugging接口),新版接口也仅支持这两种方式。 OAuth2.0比1.0的整个授权验证过程更简单、更安全,也是未来最重要的用户认证和授权方式。 OAuth2.0协议授权流程见OAuth2.0授权流程,其中Client指第三方应用,Resource Owner指用户,Authorization Server是我们的授权服务器,Resource Server是API 服务器。

参考链接:以及新浪微博开放平台和新浪微博CodeProject开源项目

开发者可以先浏览OAuth2.0的接口文档,熟悉OAuth2接口和参数的含义,然后根据应用讲解如何使用OAuth2.0场景。

OAuth2 接口文档

接口说明

OAuth2/授权

请求用户授权令牌

OAuth2/access_token

获取授权访问令牌

OAuth2/get_token_info

授权信息查询界面

OAuth2/revokeoauth2

授权恢复接口

OAuth2/get_oauth2_token

OAuth1.0的Access Token替换为OAuth2.0的Access Token

二、OAuth2.0 新浪授权页面

1、 首先获取appKey和appSecret。这种获取方式可以在新浪微博新手指南中一步步获取。这里的回调地址使用默认的:网站访问方式。以下是 C# 示例源代码(控制台应用程序):

01.using System;

02.using System.Collections.Generic;

03.using System.Linq;

04.using System.Text;

05.using NetDimension.Weibo;

06.using System.Net;

07.

08.namespace SinaWeiboTestApp

09.{

10. class Program

11. {

12.

13. static void Main(string[] args)

14. {

15.

16. string appkey = "124543453288";

17. string appsecret = "3a456c5332fd2cb1178338fccb9fa51c";

18. //string callBack = "http://127.0.0.1:3170/WebSite2/Default.aspx";

19. string callBack = "https://api.weibo.com/oauth2/default.html";

20. var oauth = new NetDimension.Weibo.OAuth(appkey,appsecret,callBack);

21.

22. ////模拟登录

23. //string username = "[email protected]";

24. //string password = "xxxxxxx";

25. //oauth.ClientLogin(username, password); //模拟登录下,没啥好说的,你也可以改成标准登录。

26.

27. //标准登录

28. var authUrl = oauth.GetAuthorizeURL();

29. //string redirectUrl;

30. //HttpWebRequest request = (HttpWebRequest)HttpWebRequest.Create(authUrl);

31. //request.Referer = authUrl;

32. //request.AllowAutoRedirect = false;

33. //using (WebResponse response = request.GetResponse())

34. //{

35. // redirectUrl = response.Headers["Location"];

36. // redirectUrl = response.ResponseUri.AbsolutePath;

37. //}

38. System.Diagnostics.Process.Start(authUrl);

39. Console.WriteLine("填写浏览器地址中的Code参数:");

40. var code = Console.ReadLine();

41. var accessToken = oauth.GetAccessTokenByAuthorizationCode(code);

42. if (!string.IsNullOrEmpty(accessToken.Token))

43. {

44. var sina = new NetDimension.Weibo.Client(oauth);

45. var uid = sina.API.Dynamic.Account.GetUID(); //调用API中获取UID的方法

46. Console.WriteLine(uid);

47. }

48.

49. var Sina = new Client(oauth);

50. Console.WriteLine("开始发送异步请求...");

51.

52. //例子1:异步获取用户的ID

53. //demo的运行环境是.net 4.0,下面展示的这种方法在2.0及以上版本环境下有效,3.0以上可以用lambda表达式来简化delegate的蛋疼写法,请看下面的例子。

54. Sina.AsyncInvoke(

55. //第一个代理中编写调用API接口的相关逻辑

56. delegate()

57. {

58. Console.WriteLine("发送请求来获得用户ID...");

59. System.Threading.Thread.Sleep(8000); //等待8秒

60. return Sina.API.Entity.Account.GetUID();

61. },

62. //第二个代理为回调函数,异步完成后将自动调用这个函数来处理结果。

63. delegate(AsyncCallback callback)

64. {

65. if (callback.IsSuccess)

66. {

67. Console.WriteLine("获取用户ID成功,ID:{0}", callback.Data);

68. }

69. else

70. {

71. Console.WriteLine("获取用户ID失败,异常:{0}", callback.Error);

72. }

73. }

74. );

75.

76. //列子2:获取公共微博列表

77. //2.0以上用lambda来写,方便不是一点点

78. Sina.AsyncInvoke(() =>

79. {

80. //获取微博,接口调用,返回值是个NetDimension.Weibo.Entities.status.Collection,所以泛型T为NetDimension.Weibo.Entities.status.Collection

81. Console.WriteLine("发送请求来获得公共微博列表...");

82. return Sina.API.Entity.Statuses.PublicTimeline();

83. //return Sina.API.Entity.Statuses.RepostTimeline;

84. }, (callback) =>

85. {

86. if (callback.IsSuccess)

87. {

88. //异步完成后处理结果,result就是返回的结果,类型就是泛型所指定的NetDimension.Weibo.Entities.status.Collection

89. Console.WriteLine("获得公共微博列表成功,现在公共频道发微博的人都是他们:");

90. foreach (var status in callback.Data.Statuses)

91. {

92. if (status.User != null)

93. Console.WriteLine(status.User.ScreenName + " ");//打印公共微博发起人的姓名

94. }

95. Console.WriteLine();

96. }

97. else

98. {

99. Console.WriteLine("获取用户ID失败,异常:{0}", callback.Error);

100. }

101.

102. });

103.

104.

105. Console.WriteLine("已发送所有异步请求。等待异步执行完成...");

106.

107. Console.ReadKey(); //阻塞,等待异步调用执行完成

108.

109. }

110.

111. }

112.}

MVC 中的代码:

using System;

using System.Collections.Generic;

using System.Linq;

using System.Web;

using System.Web.Mvc;

using Myself.Models;

using Myself.Code;

using BLL;

using Lib;

using SpeexToWavToMp3;

using System.Web.Http.Filters;

using Models;

using Webdiyer.WebControls.Mvc;

using System.IO;

namespace Myself.Controllers

{

public class MySelfController : Controller

{

public ActionResult LoginSina()

{

var oauth = new NetDimension.Weibo.OAuth(appKey,appSecret,Url.Action("LoginSinaResult", "MySelf", null, "http"));

//第一步获取新浪授权页面的地址

var oauthUrl = oauth.GetAuthorizeURL();

return Redirect(oauthUrl);

}

public ActionResult LoginSinaResult(string code)

{

var oauth = new NetDimension.Weibo.OAuth(appKey, appSecret, Url.Action("LoginSinaResult", "MySelf", null, "http"));

var oauthToken = oauth.GetAccessTokenByAuthorizationCode(code);

var model = UserHelper.GetAuthorizeInfo(oauthToken.UID, 1);

if (model != null)

{

if (LoginHelper.UserLogin(model.UserID, 1, oauthToken.UID, Request.UserAgent, Request.UserHostAddress, "1", "web"))

{

return RedirectToAction("Index", "Home");

}

else

{

return Content("登录失败");

}

}

return Content("您尚未注册");

}

}

}

要运行上述程序,需要替换Appkey和Appsecret。

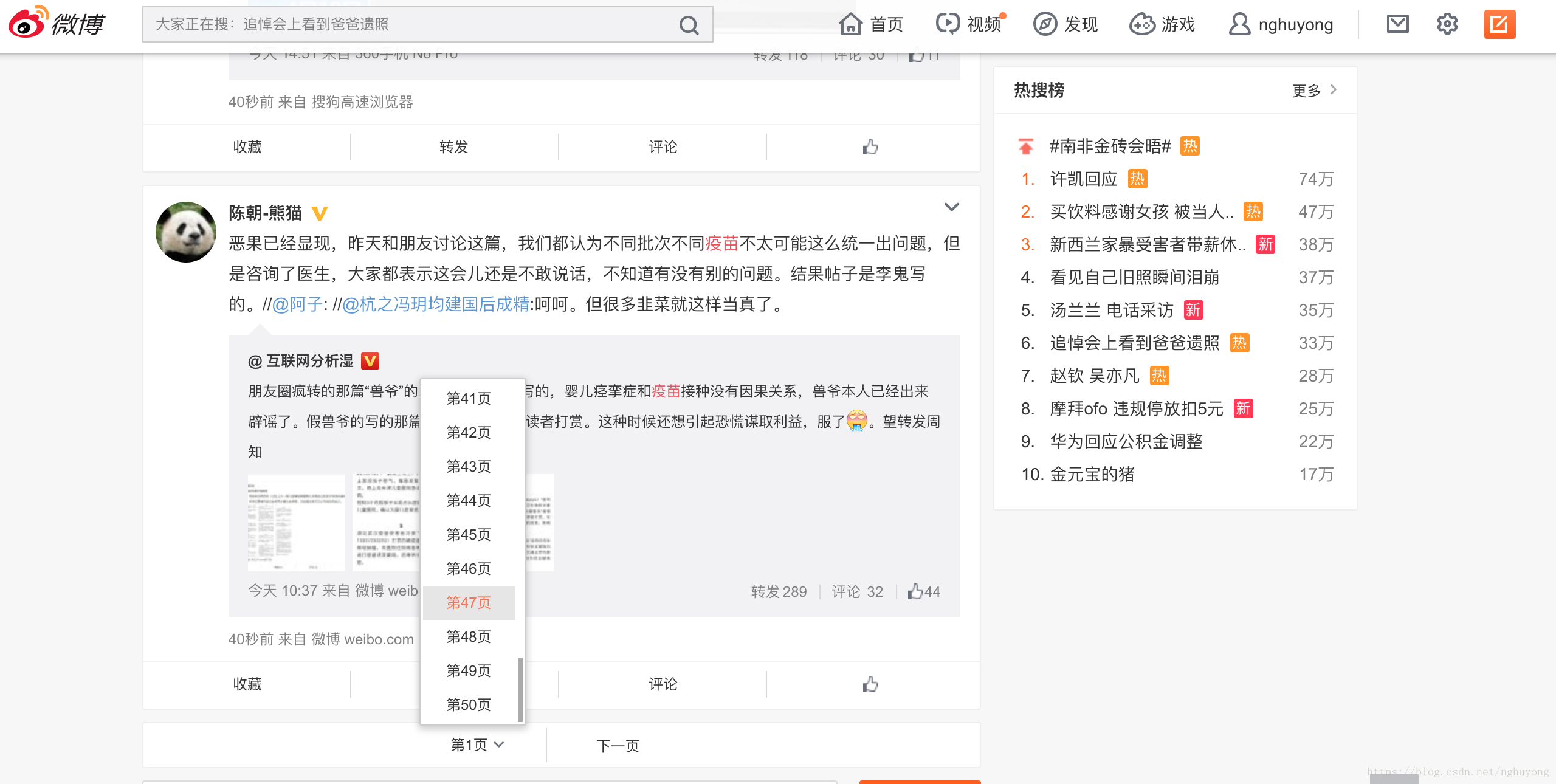

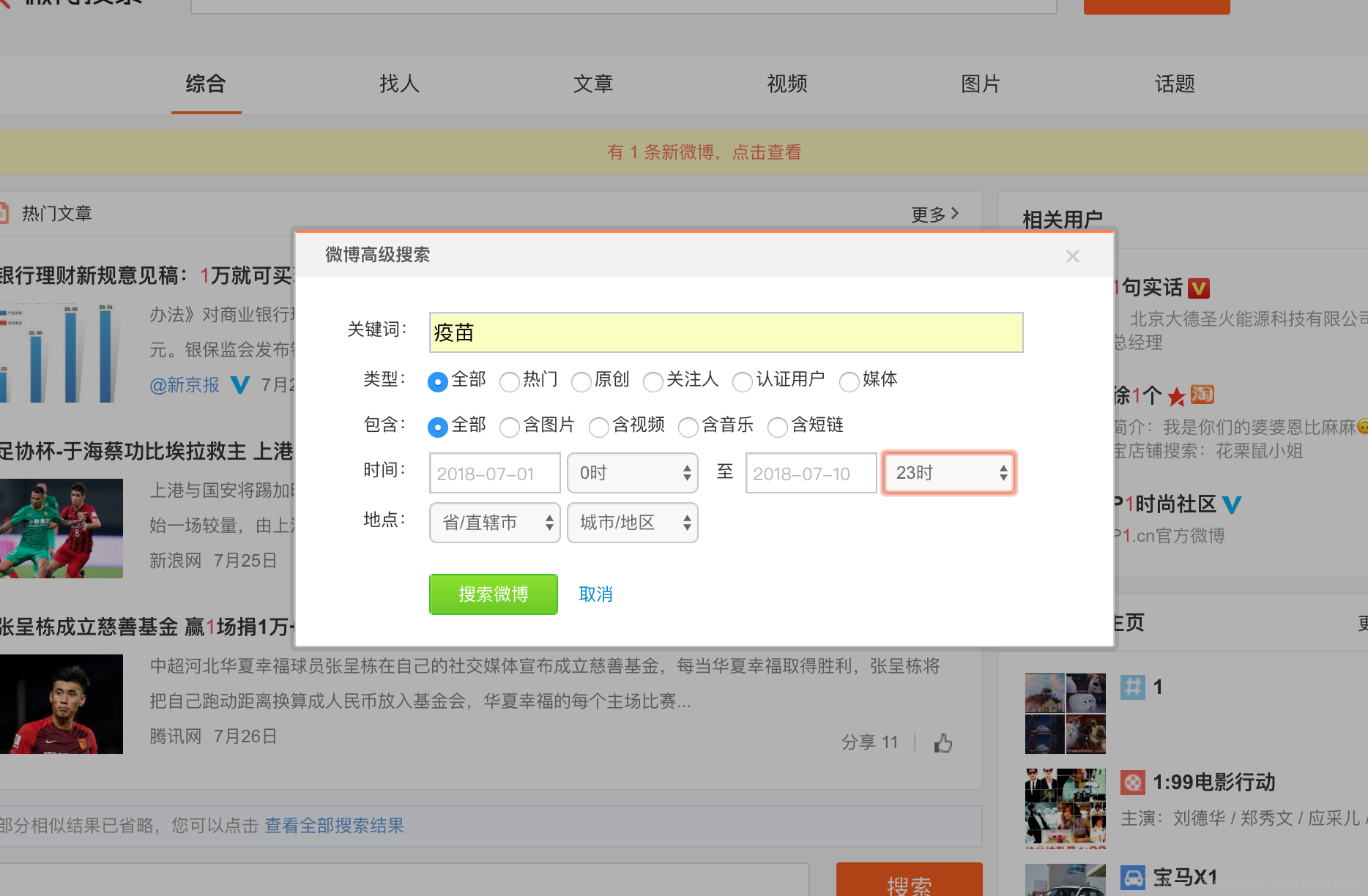

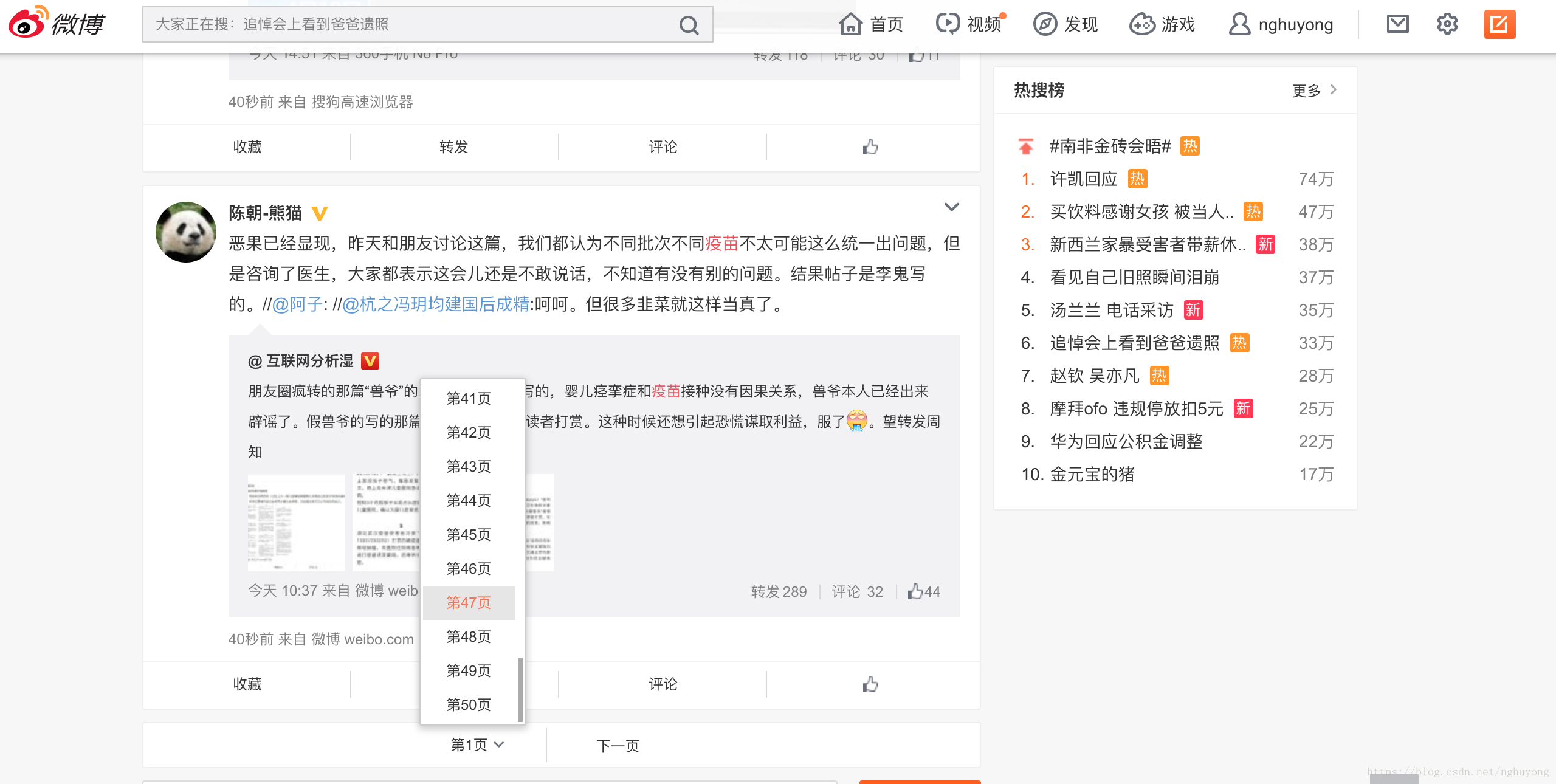

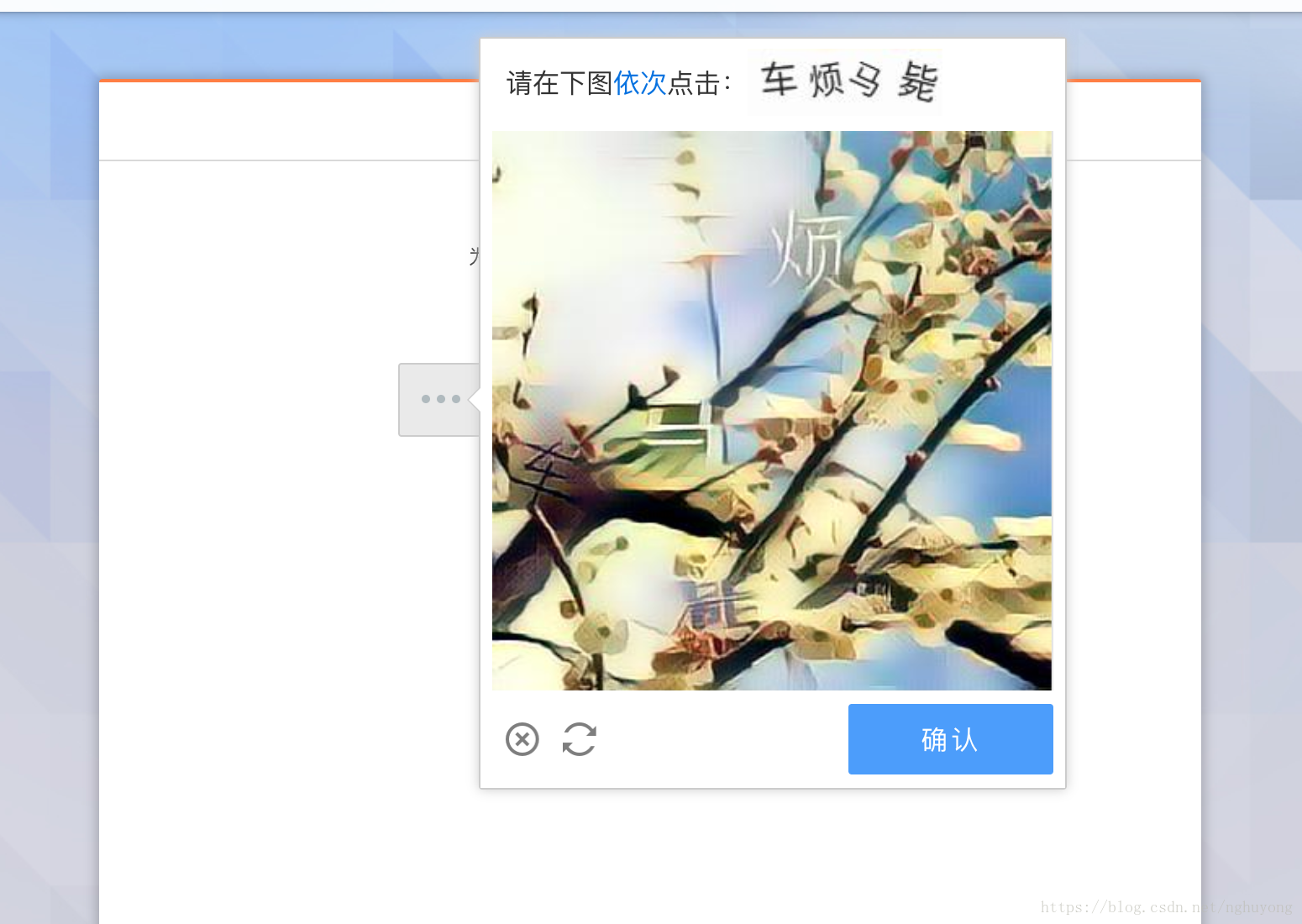

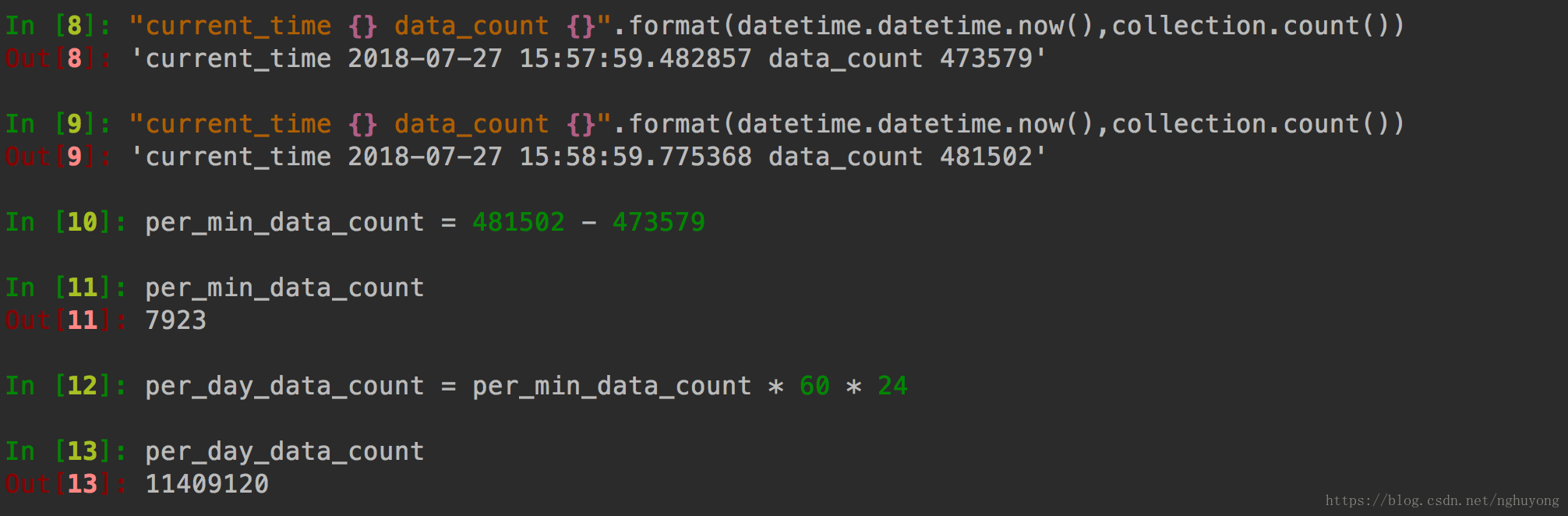

2、授权页面

以下是微博登录的界面,登录后第三方网站授权访问您新浪微博上的资源

将提供。

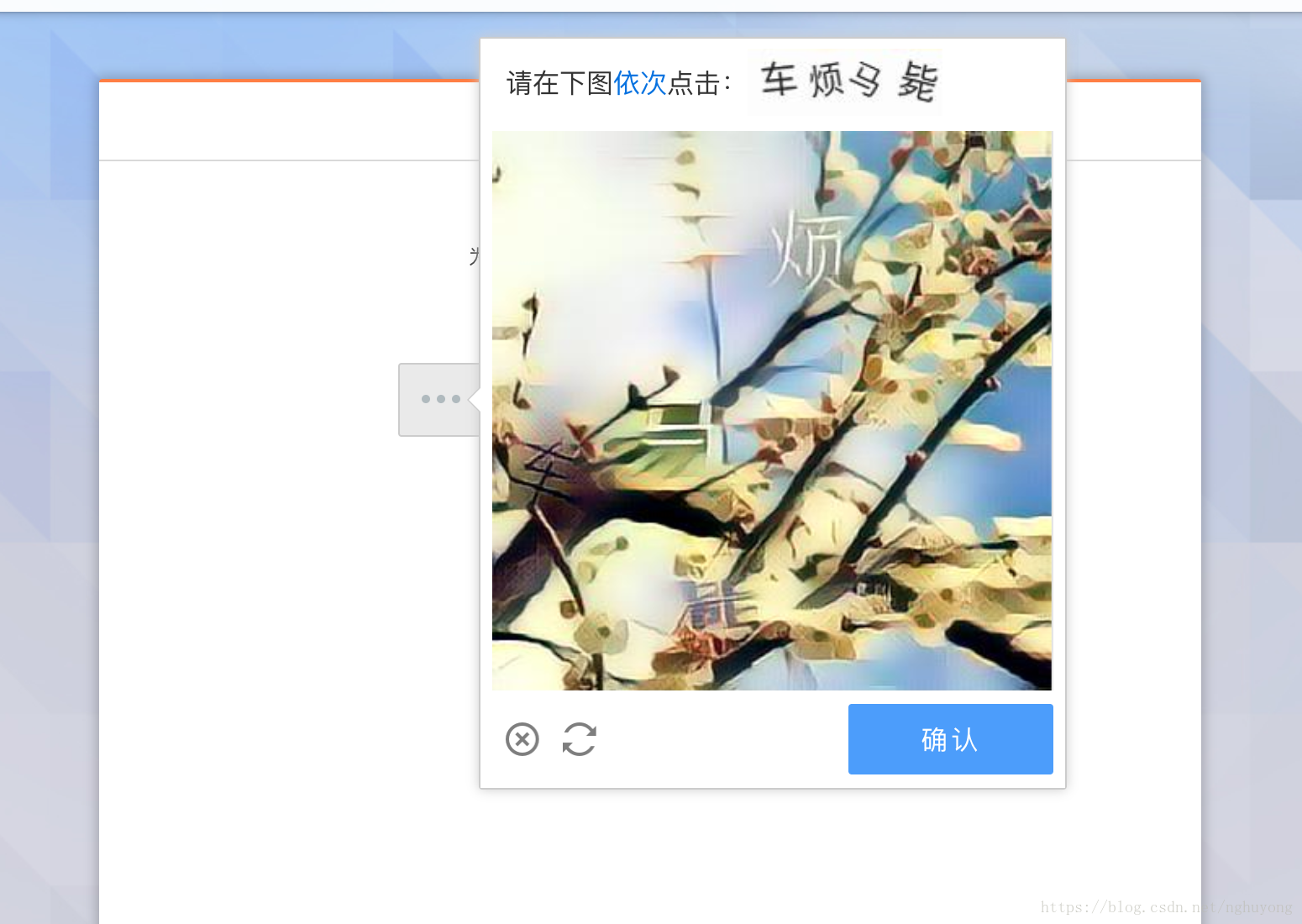

3、授权访问页面

4、新浪官方网站提供API测试工具来测试客户端构造的参数是否正确

5、Oauth2.0 操作流程图

第一步:首先直接跳转到用户授权地址,即图标Request User Url,提示用户登录,授权相关资源获取唯一Auth code。这里注意代码的有效期只有10分钟出于安全考虑,相比OAuth1.0,它节省了一步获取临时token的时间,而且有效期也有控制,比1.0简单多了,安全多了@1.0 认证;第二步:获取代码授权后,这一步是请求访问令牌,使用图标请求访问url生成数据令牌;第三步:通过Access Token请求一个OpenID,即用户在本平台的唯一标识,通过图标Request info url请求,然后得到OpenID;第四步:利用第二步获取的数据Token、第三步获取的OpenID及相关API请求获取用户授权资源信息 查看全部

网站调用新浪微博内容(OAuth2.0协议授权流程查看/access_token获取)

一、OAuth2.0概览

大多数 API 访问,例如发布微博、获取私人消息和关注,都需要用户身份。目前新浪微博开放平台用户身份认证包括OAuth2.0和Basic Auth(仅用于应用开发Debugging接口),新版接口也仅支持这两种方式。 OAuth2.0比1.0的整个授权验证过程更简单、更安全,也是未来最重要的用户认证和授权方式。 OAuth2.0协议授权流程见OAuth2.0授权流程,其中Client指第三方应用,Resource Owner指用户,Authorization Server是我们的授权服务器,Resource Server是API 服务器。

参考链接:以及新浪微博开放平台和新浪微博CodeProject开源项目

开发者可以先浏览OAuth2.0的接口文档,熟悉OAuth2接口和参数的含义,然后根据应用讲解如何使用OAuth2.0场景。

OAuth2 接口文档

接口说明

OAuth2/授权

请求用户授权令牌

OAuth2/access_token

获取授权访问令牌

OAuth2/get_token_info

授权信息查询界面

OAuth2/revokeoauth2

授权恢复接口

OAuth2/get_oauth2_token

OAuth1.0的Access Token替换为OAuth2.0的Access Token

二、OAuth2.0 新浪授权页面

1、 首先获取appKey和appSecret。这种获取方式可以在新浪微博新手指南中一步步获取。这里的回调地址使用默认的:网站访问方式。以下是 C# 示例源代码(控制台应用程序):

01.using System;

02.using System.Collections.Generic;

03.using System.Linq;

04.using System.Text;

05.using NetDimension.Weibo;

06.using System.Net;

07.

08.namespace SinaWeiboTestApp

09.{

10. class Program

11. {

12.

13. static void Main(string[] args)

14. {

15.

16. string appkey = "124543453288";

17. string appsecret = "3a456c5332fd2cb1178338fccb9fa51c";

18. //string callBack = "http://127.0.0.1:3170/WebSite2/Default.aspx";

19. string callBack = "https://api.weibo.com/oauth2/default.html";

20. var oauth = new NetDimension.Weibo.OAuth(appkey,appsecret,callBack);

21.

22. ////模拟登录

23. //string username = "[email protected]";

24. //string password = "xxxxxxx";

25. //oauth.ClientLogin(username, password); //模拟登录下,没啥好说的,你也可以改成标准登录。

26.

27. //标准登录

28. var authUrl = oauth.GetAuthorizeURL();

29. //string redirectUrl;

30. //HttpWebRequest request = (HttpWebRequest)HttpWebRequest.Create(authUrl);

31. //request.Referer = authUrl;

32. //request.AllowAutoRedirect = false;

33. //using (WebResponse response = request.GetResponse())

34. //{

35. // redirectUrl = response.Headers["Location"];

36. // redirectUrl = response.ResponseUri.AbsolutePath;

37. //}

38. System.Diagnostics.Process.Start(authUrl);

39. Console.WriteLine("填写浏览器地址中的Code参数:");

40. var code = Console.ReadLine();

41. var accessToken = oauth.GetAccessTokenByAuthorizationCode(code);

42. if (!string.IsNullOrEmpty(accessToken.Token))

43. {

44. var sina = new NetDimension.Weibo.Client(oauth);

45. var uid = sina.API.Dynamic.Account.GetUID(); //调用API中获取UID的方法

46. Console.WriteLine(uid);

47. }

48.

49. var Sina = new Client(oauth);

50. Console.WriteLine("开始发送异步请求...");

51.

52. //例子1:异步获取用户的ID

53. //demo的运行环境是.net 4.0,下面展示的这种方法在2.0及以上版本环境下有效,3.0以上可以用lambda表达式来简化delegate的蛋疼写法,请看下面的例子。

54. Sina.AsyncInvoke(

55. //第一个代理中编写调用API接口的相关逻辑

56. delegate()

57. {

58. Console.WriteLine("发送请求来获得用户ID...");

59. System.Threading.Thread.Sleep(8000); //等待8秒

60. return Sina.API.Entity.Account.GetUID();

61. },

62. //第二个代理为回调函数,异步完成后将自动调用这个函数来处理结果。

63. delegate(AsyncCallback callback)

64. {

65. if (callback.IsSuccess)

66. {

67. Console.WriteLine("获取用户ID成功,ID:{0}", callback.Data);

68. }

69. else

70. {

71. Console.WriteLine("获取用户ID失败,异常:{0}", callback.Error);

72. }

73. }

74. );

75.

76. //列子2:获取公共微博列表

77. //2.0以上用lambda来写,方便不是一点点

78. Sina.AsyncInvoke(() =>

79. {

80. //获取微博,接口调用,返回值是个NetDimension.Weibo.Entities.status.Collection,所以泛型T为NetDimension.Weibo.Entities.status.Collection

81. Console.WriteLine("发送请求来获得公共微博列表...");

82. return Sina.API.Entity.Statuses.PublicTimeline();

83. //return Sina.API.Entity.Statuses.RepostTimeline;

84. }, (callback) =>

85. {

86. if (callback.IsSuccess)

87. {

88. //异步完成后处理结果,result就是返回的结果,类型就是泛型所指定的NetDimension.Weibo.Entities.status.Collection

89. Console.WriteLine("获得公共微博列表成功,现在公共频道发微博的人都是他们:");

90. foreach (var status in callback.Data.Statuses)

91. {

92. if (status.User != null)

93. Console.WriteLine(status.User.ScreenName + " ");//打印公共微博发起人的姓名

94. }

95. Console.WriteLine();

96. }

97. else

98. {

99. Console.WriteLine("获取用户ID失败,异常:{0}", callback.Error);

100. }

101.

102. });

103.

104.

105. Console.WriteLine("已发送所有异步请求。等待异步执行完成...");

106.

107. Console.ReadKey(); //阻塞,等待异步调用执行完成

108.

109. }

110.

111. }

112.}

MVC 中的代码:

using System;

using System.Collections.Generic;

using System.Linq;

using System.Web;

using System.Web.Mvc;

using Myself.Models;

using Myself.Code;

using BLL;

using Lib;

using SpeexToWavToMp3;

using System.Web.Http.Filters;

using Models;

using Webdiyer.WebControls.Mvc;

using System.IO;

namespace Myself.Controllers

{

public class MySelfController : Controller

{

public ActionResult LoginSina()

{

var oauth = new NetDimension.Weibo.OAuth(appKey,appSecret,Url.Action("LoginSinaResult", "MySelf", null, "http"));

//第一步获取新浪授权页面的地址

var oauthUrl = oauth.GetAuthorizeURL();

return Redirect(oauthUrl);

}

public ActionResult LoginSinaResult(string code)

{

var oauth = new NetDimension.Weibo.OAuth(appKey, appSecret, Url.Action("LoginSinaResult", "MySelf", null, "http"));

var oauthToken = oauth.GetAccessTokenByAuthorizationCode(code);

var model = UserHelper.GetAuthorizeInfo(oauthToken.UID, 1);

if (model != null)

{

if (LoginHelper.UserLogin(model.UserID, 1, oauthToken.UID, Request.UserAgent, Request.UserHostAddress, "1", "web"))

{

return RedirectToAction("Index", "Home");

}

else

{

return Content("登录失败");

}

}

return Content("您尚未注册");

}

}

}

要运行上述程序,需要替换Appkey和Appsecret。

2、授权页面

以下是微博登录的界面,登录后第三方网站授权访问您新浪微博上的资源

将提供。

3、授权访问页面

4、新浪官方网站提供API测试工具来测试客户端构造的参数是否正确

5、Oauth2.0 操作流程图

第一步:首先直接跳转到用户授权地址,即图标Request User Url,提示用户登录,授权相关资源获取唯一Auth code。这里注意代码的有效期只有10分钟出于安全考虑,相比OAuth1.0,它节省了一步获取临时token的时间,而且有效期也有控制,比1.0简单多了,安全多了@1.0 认证;第二步:获取代码授权后,这一步是请求访问令牌,使用图标请求访问url生成数据令牌;第三步:通过Access Token请求一个OpenID,即用户在本平台的唯一标识,通过图标Request info url请求,然后得到OpenID;第四步:利用第二步获取的数据Token、第三步获取的OpenID及相关API请求获取用户授权资源信息

网站调用新浪微博内容(微博登录访问第三方网站,分享内容,同步信息。。)

网站优化 • 优采云 发表了文章 • 0 个评论 • 62 次浏览 • 2021-11-05 05:09

在平时的项目开发过程中,除了注册这个网站账号登录外,还可以调用第三方接口登录网站。这里我们以微博登录为例。微博登录包括身份认证、用户关系和内容传播。允许用户使用微博账号登录访问第三方网站,分享内容,同步信息。

1、首先需要将需要授权的用户引导到以下地址:

如果用户同意授权,页面跳转到your_registered_redirect_uri/?code=code:

2、 接下来,我们需要根据上面得到的代码换取访问令牌:

返回值:

json

{

"access_token": "slav32hkkg",

"remind_in": 3600,

"expires_in": 3600

}

3、最后使用获取到的oauth2.0 access token调用API获取用户身份,完成用户登录。

话不多说,直接上代码:

为方便起见,我们先将get和post封装到application下的common.php中:

应用公用文件common.php:

function get( $url, $_header = null )

{

$curl = curl_init();

//curl_setopt ( $curl, curlopt_safe_upload, false);

if( stripos($url, 'https://') !==false )

{

curl_setopt($curl, curlopt_ssl_verifypeer, false);

curl_setopt($curl, curlopt_ssl_verifyhost, false);

}

curl_setopt($curl, curlopt_url, $url);

curl_setopt($curl, curlopt_header, 0);

curl_setopt($curl, curlopt_returntransfer, 1);

if ( $_header != null )

{

curl_setopt($curl, curlopt_httpheader, $_header);

}

$ret = curl_exec($curl);

$info = curl_getinfo($curl);

curl_close($curl);

if( intval( $info["http_code"] ) == 200 )

{

return $ret;

}

return false;

}

/*

* post method

*/

function post( $url, $param )

{

$ocurl = curl_init ();

curl_setopt ( $ocurl, curlopt_safe_upload, false);

if (stripos ( $url, "https://" ) !== false) {

curl_setopt ( $ocurl, curlopt_ssl_verifypeer, false );

curl_setopt ( $ocurl, curlopt_ssl_verifyhost, false );

}

curl_setopt ( $ocurl, curlopt_url, $url );

curl_setopt ( $ocurl, curlopt_returntransfer, 1 );

curl_setopt ( $ocurl, curlopt_post, true );

curl_setopt ( $ocurl, curlopt_postfields, $param );

$scontent = curl_exec ( $ocurl );

$astatus = curl_getinfo ( $ocurl );

curl_close ( $ocurl );

if (intval ( $astatus ["http_code"] ) == 200) {

return $scontent;

} else {

return false;

}

}

控制器处理代码login.php:

class login extends \think\controller

{

public function index()

{

$key = "****";

$redirect_uri = "***微博应用安全域名***/?backurl=***项目本地域名***/home/login/weblogin?";

//授权后将页面重定向到本地项目

$redirect_uri = urlencode($redirect_uri);

$wb_url = "https://api.weibo.com/oauth2/authorize?client_id={$key}&response_type=code&redirect_uri={$redirect_uri}";

$this -> assign('wb_url',$wb_url);

return view('login');

}

public function weblogin(){

$key = "*****";

//接收code值

$code = input('get.code');

//换取access token: post方式请求 替换参数: client_id, client_secret,redirect_uri, code

$secret = "********";

$redirect_uri = "********";

$url = "https://api.weibo.com/oauth2/a ... id%3D{$key}&client_secret={$secret}&grant_type=authorization_code&redirect_uri={$redirect_uri}&code={$code}";

$token = post($url, array());

$token = json_decode($token, true);

//获取用户信息 : get方法,替换参数: access_token, uid

$url = "https://api.weibo.com/2/users/ ... en%3D{$token['access_token']}&uid={$token['uid']}";

$info = get($url);

if($info){

echo "<p>登录成功";

}

}

}</p>

模板代码 login.html:

微博登录

点击这里进行微博登录

效果图:

以上就是本文的全部内容,希望对大家的学习有所帮助,也希望大家多多支持万千网。 查看全部

网站调用新浪微博内容(微博登录访问第三方网站,分享内容,同步信息。。)

在平时的项目开发过程中,除了注册这个网站账号登录外,还可以调用第三方接口登录网站。这里我们以微博登录为例。微博登录包括身份认证、用户关系和内容传播。允许用户使用微博账号登录访问第三方网站,分享内容,同步信息。

1、首先需要将需要授权的用户引导到以下地址:

如果用户同意授权,页面跳转到your_registered_redirect_uri/?code=code:

2、 接下来,我们需要根据上面得到的代码换取访问令牌:

返回值:

json

{

"access_token": "slav32hkkg",

"remind_in": 3600,

"expires_in": 3600

}

3、最后使用获取到的oauth2.0 access token调用API获取用户身份,完成用户登录。

话不多说,直接上代码:

为方便起见,我们先将get和post封装到application下的common.php中:

应用公用文件common.php:

function get( $url, $_header = null )

{

$curl = curl_init();

//curl_setopt ( $curl, curlopt_safe_upload, false);

if( stripos($url, 'https://') !==false )

{

curl_setopt($curl, curlopt_ssl_verifypeer, false);

curl_setopt($curl, curlopt_ssl_verifyhost, false);

}

curl_setopt($curl, curlopt_url, $url);

curl_setopt($curl, curlopt_header, 0);

curl_setopt($curl, curlopt_returntransfer, 1);

if ( $_header != null )

{

curl_setopt($curl, curlopt_httpheader, $_header);

}

$ret = curl_exec($curl);

$info = curl_getinfo($curl);

curl_close($curl);

if( intval( $info["http_code"] ) == 200 )

{

return $ret;

}

return false;

}

/*

* post method

*/

function post( $url, $param )

{

$ocurl = curl_init ();

curl_setopt ( $ocurl, curlopt_safe_upload, false);

if (stripos ( $url, "https://" ) !== false) {

curl_setopt ( $ocurl, curlopt_ssl_verifypeer, false );

curl_setopt ( $ocurl, curlopt_ssl_verifyhost, false );

}

curl_setopt ( $ocurl, curlopt_url, $url );

curl_setopt ( $ocurl, curlopt_returntransfer, 1 );

curl_setopt ( $ocurl, curlopt_post, true );

curl_setopt ( $ocurl, curlopt_postfields, $param );

$scontent = curl_exec ( $ocurl );

$astatus = curl_getinfo ( $ocurl );

curl_close ( $ocurl );

if (intval ( $astatus ["http_code"] ) == 200) {

return $scontent;

} else {

return false;

}

}

控制器处理代码login.php:

class login extends \think\controller

{

public function index()

{

$key = "****";

$redirect_uri = "***微博应用安全域名***/?backurl=***项目本地域名***/home/login/weblogin?";

//授权后将页面重定向到本地项目

$redirect_uri = urlencode($redirect_uri);

$wb_url = "https://api.weibo.com/oauth2/authorize?client_id={$key}&response_type=code&redirect_uri={$redirect_uri}";

$this -> assign('wb_url',$wb_url);

return view('login');

}

public function weblogin(){

$key = "*****";

//接收code值

$code = input('get.code');

//换取access token: post方式请求 替换参数: client_id, client_secret,redirect_uri, code

$secret = "********";

$redirect_uri = "********";

$url = "https://api.weibo.com/oauth2/a ... id%3D{$key}&client_secret={$secret}&grant_type=authorization_code&redirect_uri={$redirect_uri}&code={$code}";

$token = post($url, array());

$token = json_decode($token, true);

//获取用户信息 : get方法,替换参数: access_token, uid

$url = "https://api.weibo.com/2/users/ ... en%3D{$token['access_token']}&uid={$token['uid']}";

$info = get($url);

if($info){

echo "<p>登录成功";

}

}

}</p>

模板代码 login.html:

微博登录

点击这里进行微博登录

效果图:

以上就是本文的全部内容,希望对大家的学习有所帮助,也希望大家多多支持万千网。

网站调用新浪微博内容(QQ和新浪微博登录门槛的降低就已经做到了!)

网站优化 • 优采云 发表了文章 • 0 个评论 • 61 次浏览 • 2021-11-02 16:18

网站引入QQ和新浪微博登录后,实现了网站登录门槛的降低,因为这两个基本上所有网名都可以使用,尤其是QQ。下载这两种登录方式的详细说明。

1.QQ需要申请认证,创建应用申请。如下所示:

点击网站,填写网站信息,如下图:

点击创建应用,等待审核。审核通过后,我们就可以使用基本的API了。以下是QQ互联API列表。

这是调用代码:

//引入JS脚本

QC.Login({

btnId: "qq_login_btn",

scope: "all",

},

function() {

QC.api("get_user_info").success(function(s) {

var paras = {

format: "json"

};

QC.api("get_info", paras).success(function(w) {

var data = eval(w.data);

var weiboUrl = "http://t.qq.com/" data.data.name;

var lc = data.data.location;

}).error(function(e) {

}).complete(function(c) { //完成请求回调

var nickName = s.data.nickname; //称谓

var userQQSmallImage = s.data.figureurl_qq_1; //大小为40×40像素的QQ头像URL。

userQQLargeImage = s.data.figureurl_qq_2; //大小为100×100像素的QQ头像URL。

var userQQZoneImage = s.data.figureurl_1; //大小为50×50像素的QQ空间头像URL

});

});

});

" _ue_custom_node_="true">

演示地址:

2.新浪微博:

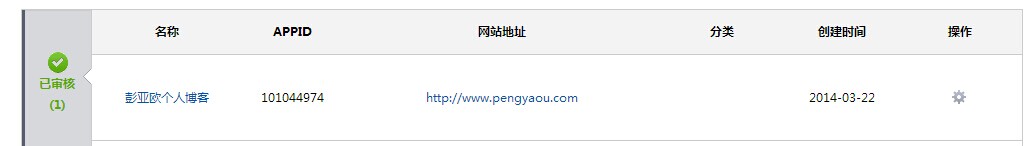

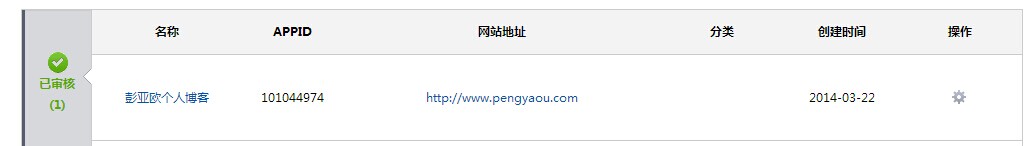

登录新浪微博开放平台,点击进入管理中心,点击添加网站,先验证网站的所有权,验证后会添加到我的网站,不是我们刚刚填写的在线专栏网站,那么您需要提交审核。审核后就可以拿到APPID了,就可以使用了。

详细接口信息:

%E5%BE%AE%E5%8D%9AAPI

登录按钮介绍及代码:

function login(o) {

//

$.ajax({

type: "Get",

url: "https://api.weibo.com/2/users/ ... ot%3B + o.screen_name + "",

dataType: "jsonp",

success: function(data) {

var lc = data.data.location;

var nickName = o.screen_name;

var userQQLargeImage = o.avatar_large;

var weiboUrl = "http://weibo.com/u/" + o.idstr;

// document.getElementById("Friend").style.display = "block";

// document.getElementById("LoginA").style.display = "none";

// document.getElementById("FriendImg").src = o.avatar_large;

// document.getElementById("FriendName").innerHTML = o.screen_name + "(来自新浪微博登录)";

},

error: function(xhr, msg, e) {

alert(msg);

}

});

}

function logout() {

alert('logout');

}

QQ登录和新浪微博登录方式非常相似,步骤也一样。一般是申请认证,导入code,接收回调,注销。如果您需要使用一些更高级的API,我们需要单独申请。这里就不介绍了。 查看全部

网站调用新浪微博内容(QQ和新浪微博登录门槛的降低就已经做到了!)

网站引入QQ和新浪微博登录后,实现了网站登录门槛的降低,因为这两个基本上所有网名都可以使用,尤其是QQ。下载这两种登录方式的详细说明。

1.QQ需要申请认证,创建应用申请。如下所示:

点击网站,填写网站信息,如下图:

点击创建应用,等待审核。审核通过后,我们就可以使用基本的API了。以下是QQ互联API列表。

这是调用代码:

//引入JS脚本

QC.Login({

btnId: "qq_login_btn",

scope: "all",

},

function() {

QC.api("get_user_info").success(function(s) {

var paras = {

format: "json"

};

QC.api("get_info", paras).success(function(w) {

var data = eval(w.data);

var weiboUrl = "http://t.qq.com/" data.data.name;

var lc = data.data.location;

}).error(function(e) {

}).complete(function(c) { //完成请求回调

var nickName = s.data.nickname; //称谓

var userQQSmallImage = s.data.figureurl_qq_1; //大小为40×40像素的QQ头像URL。

userQQLargeImage = s.data.figureurl_qq_2; //大小为100×100像素的QQ头像URL。

var userQQZoneImage = s.data.figureurl_1; //大小为50×50像素的QQ空间头像URL

});

});

});

" _ue_custom_node_="true">

演示地址:

2.新浪微博:

登录新浪微博开放平台,点击进入管理中心,点击添加网站,先验证网站的所有权,验证后会添加到我的网站,不是我们刚刚填写的在线专栏网站,那么您需要提交审核。审核后就可以拿到APPID了,就可以使用了。

详细接口信息:

%E5%BE%AE%E5%8D%9AAPI

登录按钮介绍及代码:

function login(o) {

//

$.ajax({

type: "Get",

url: "https://api.weibo.com/2/users/ ... ot%3B + o.screen_name + "",

dataType: "jsonp",

success: function(data) {

var lc = data.data.location;

var nickName = o.screen_name;

var userQQLargeImage = o.avatar_large;

var weiboUrl = "http://weibo.com/u/" + o.idstr;

// document.getElementById("Friend").style.display = "block";

// document.getElementById("LoginA").style.display = "none";

// document.getElementById("FriendImg").src = o.avatar_large;

// document.getElementById("FriendName").innerHTML = o.screen_name + "(来自新浪微博登录)";

},

error: function(xhr, msg, e) {

alert(msg);

}

});

}

function logout() {

alert('logout');

}

QQ登录和新浪微博登录方式非常相似,步骤也一样。一般是申请认证,导入code,接收回调,注销。如果您需要使用一些更高级的API,我们需要单独申请。这里就不介绍了。

网站调用新浪微博内容(批量删除新浪微博的原理分析(图)JS代码 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 127 次浏览 • 2021-11-01 21:20

)

新浪微博开放平台删除接口已关闭。目前没有其他方法可以有效删除微博。网页版微博可以通过AJAX请求删除。唯一的参数是mid,我们可以理解为唯一的微博。ID,那么我们只需要获取这个ID并发起请求即可。

新浪微博的翻页使用直接嵌套的HTML代码,里面收录了你看到的所有信息,然后我们可以模拟用户操作,批量删除微博。

原理分析

首先,构建一个 curl 方法。为了识别登录用户,我们首先要设置cookie:

function post($url, $post_data, $method = 'post', $location = 0, $reffer = null, $origin = null, $host = null){

$header = array(

'Host: weibo.com',

'User-Agent: Mozilla/5.0 (Windows NT 6.1; Win64; x64; rv:84.0) Gecko/20100101 Firefox/84.0',

'Accept: */*',

'Accept-Language: zh-CN,zh;q=0.8,zh-TW;q=0.7,zh-HK;q=0.5,en-US;q=0.3,en;q=0.2',

'Accept-Encoding: gzip, deflate, br',

'Connection: keep-alive',

'Referer: https://weibo.com/p/1006061848 ... ll%3D1',

'Cookie: SUB=_2A25Nei59DeRhGedG71oW8SfIyz6IHXVuDhi1rDV8PUNbmtANLWTxkW9NUTJhgRrUko8Y3kcSMy2qik69SLr5cWOz; SUBP=0033WrSXqPxfM725Ws9jqgMF55529P9D9W5hXoza0gdfeO6EFBAyGQ6P5JpX5KzhUgL.Fo2RShnNeK.Xehz2dJLoIpjLxK.L1KMLB--LxKnLB-qLBoBLxKMLB.BL1K2t; login_sid_t=d86405009f566cd57c8b433b74b96be8; cross_origin_proto=SSL; WBStorage=8daec78e6a891122|undefined; _s_tentry=passport.weibo.com; Apache=2936390402941.201.1618894353597; SINAGLOBAL=2936390402941.201.1618894353597; ULV=1618894353599:1:1:1:2936390402941.201.1618894353597:; wb_view_log=1920*10801; ALF=1650430381; SSOLoginState=1618894382; wb_view_log_1848719402=1920*10801; webim_unReadCount=%7B%22time%22%3A1618894400887%2C%22dm_pub_total%22%3A0%2C%22chat_group_client%22%3A0%2C%22chat_group_notice%22%3A0%2C%22allcountNum%22%3A0%2C%22msgbox%22%3A0%7D',

'X-Requested-With: XMLHttpRequest',

);

$curl = curl_init(); // 这里并没有带参数初始化

curl_setopt($curl, CURLOPT_URL, $url); // 这里传入url

curl_setopt($curl, CURLOPT_HTTPHEADER, $header);

curl_setopt($curl, CURLOPT_SSL_VERIFYPEER, 0); // 对认证证书来源的检查,不开启次功能

curl_setopt($curl, CURLOPT_SSL_VERIFYHOST, 2); // 从证书中检测 SSL 加密算法

curl_setopt($curl, CURLOPT_USERAGENT, "Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/75.0.3770.100 Safari/537.36");

curl_setopt($curl, CURLOPT_AUTOREFERER, 1);

curl_setopt($curl, CURLOPT_POST, $method == 'post'?true:false); // 开启 post

curl_setopt($curl, CURLOPT_ENCODING, "gzip, deflate" );

curl_setopt($curl, CURLOPT_POSTFIELDS, $post_data); // 要传送的数据

curl_setopt($curl, CURLOPT_TIMEOUT, 30); // 设置超时限制,防止死循环

curl_setopt($curl, CURLOPT_HEADER, 0);

curl_setopt($curl, CURLOPT_RETURNTRANSFER, 1);

$tmpInfo = curl_exec($curl);

return $tmpInfo;

}

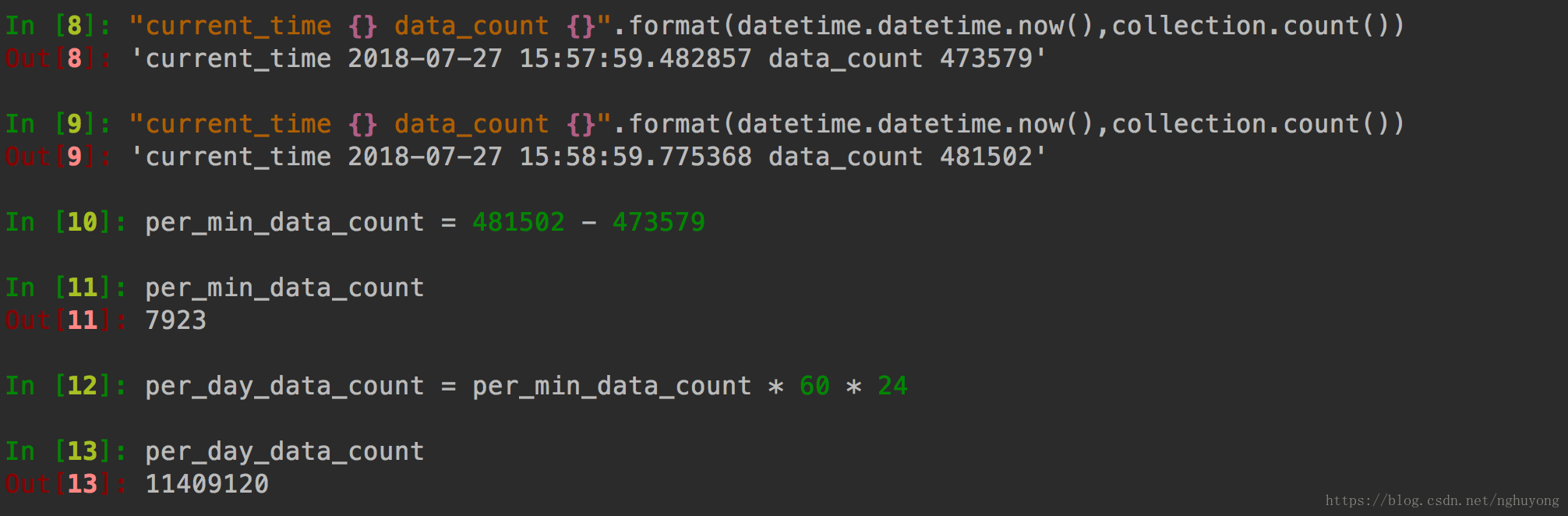

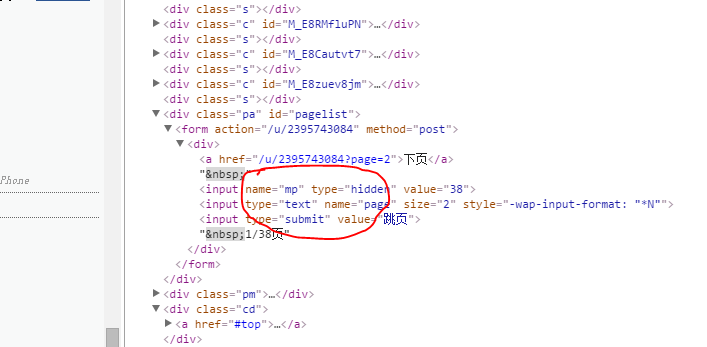

通过浏览器调试工具,我们可以找到翻页的URL地址:

%2Fp%2F19402%2Fhome%3Ffrom%3Dpage_100606%26mod%3DTAB%26is_all%3D1%23place&_t=FM_9555

page 参数是页码。这个请求得到的是一段JS代码,在页面上执行可以加载更多的微博内容,但是我们只需要里面的mid参数即可。

您可以使用常规匹配来:

preg_match_all('/mid=\\\"(.+?)\\\"/', $res, $match);

同样,删除的url是:

参数为中。如果请求成功,您将获得:

{"code":"100000","msg":"","data":{}}

完整代码

至此,我们已经基本分析清楚了,完整的代码如下:

include_once('curl_post.php');

while(1){

$url = "https://weibo.com/p/1006061848 ... 3B%3B

$res = post($url, null, 'get');

preg_match_all('/mid=\\\"(.+?)\\\"/', $res, $match);

print_r($match[1]);

foreach($match[1] as $key => $mid){

echo "start del ".$mid." ==============\r\n";

$res = post('https://weibo.com/aj/mblog/del?ajwvr=6', array('mid' => $mid));

echo $res."\r\n";

echo 'await 5s ================='."\r\n";

sleep(5);

}

if(count($match[1]) < 10) break;

}

执行php delWeibo.php,结果如下:

如果觉得等待时间太长,可以自行修改。建议不要太频繁地调用它。

这个调用可以批量删除微博,但是不方便。例如,如果你想保留一些内容,这是不够的。推荐使用我开发的另一个软件:可以手动选择一个键进行删除,精确控制删除动作。

'PHP' 不是内部或外部命令,也不是可执行程序或批处理文件。

将PHP的安装路径添加到环境变量中,就可以在命令行执行PHP文件了。

查看全部

网站调用新浪微博内容(批量删除新浪微博的原理分析(图)JS代码

)

新浪微博开放平台删除接口已关闭。目前没有其他方法可以有效删除微博。网页版微博可以通过AJAX请求删除。唯一的参数是mid,我们可以理解为唯一的微博。ID,那么我们只需要获取这个ID并发起请求即可。

新浪微博的翻页使用直接嵌套的HTML代码,里面收录了你看到的所有信息,然后我们可以模拟用户操作,批量删除微博。

原理分析

首先,构建一个 curl 方法。为了识别登录用户,我们首先要设置cookie:

function post($url, $post_data, $method = 'post', $location = 0, $reffer = null, $origin = null, $host = null){

$header = array(

'Host: weibo.com',

'User-Agent: Mozilla/5.0 (Windows NT 6.1; Win64; x64; rv:84.0) Gecko/20100101 Firefox/84.0',

'Accept: */*',

'Accept-Language: zh-CN,zh;q=0.8,zh-TW;q=0.7,zh-HK;q=0.5,en-US;q=0.3,en;q=0.2',

'Accept-Encoding: gzip, deflate, br',

'Connection: keep-alive',

'Referer: https://weibo.com/p/1006061848 ... ll%3D1',

'Cookie: SUB=_2A25Nei59DeRhGedG71oW8SfIyz6IHXVuDhi1rDV8PUNbmtANLWTxkW9NUTJhgRrUko8Y3kcSMy2qik69SLr5cWOz; SUBP=0033WrSXqPxfM725Ws9jqgMF55529P9D9W5hXoza0gdfeO6EFBAyGQ6P5JpX5KzhUgL.Fo2RShnNeK.Xehz2dJLoIpjLxK.L1KMLB--LxKnLB-qLBoBLxKMLB.BL1K2t; login_sid_t=d86405009f566cd57c8b433b74b96be8; cross_origin_proto=SSL; WBStorage=8daec78e6a891122|undefined; _s_tentry=passport.weibo.com; Apache=2936390402941.201.1618894353597; SINAGLOBAL=2936390402941.201.1618894353597; ULV=1618894353599:1:1:1:2936390402941.201.1618894353597:; wb_view_log=1920*10801; ALF=1650430381; SSOLoginState=1618894382; wb_view_log_1848719402=1920*10801; webim_unReadCount=%7B%22time%22%3A1618894400887%2C%22dm_pub_total%22%3A0%2C%22chat_group_client%22%3A0%2C%22chat_group_notice%22%3A0%2C%22allcountNum%22%3A0%2C%22msgbox%22%3A0%7D',

'X-Requested-With: XMLHttpRequest',

);

$curl = curl_init(); // 这里并没有带参数初始化

curl_setopt($curl, CURLOPT_URL, $url); // 这里传入url

curl_setopt($curl, CURLOPT_HTTPHEADER, $header);

curl_setopt($curl, CURLOPT_SSL_VERIFYPEER, 0); // 对认证证书来源的检查,不开启次功能

curl_setopt($curl, CURLOPT_SSL_VERIFYHOST, 2); // 从证书中检测 SSL 加密算法

curl_setopt($curl, CURLOPT_USERAGENT, "Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/75.0.3770.100 Safari/537.36");

curl_setopt($curl, CURLOPT_AUTOREFERER, 1);

curl_setopt($curl, CURLOPT_POST, $method == 'post'?true:false); // 开启 post

curl_setopt($curl, CURLOPT_ENCODING, "gzip, deflate" );

curl_setopt($curl, CURLOPT_POSTFIELDS, $post_data); // 要传送的数据

curl_setopt($curl, CURLOPT_TIMEOUT, 30); // 设置超时限制,防止死循环

curl_setopt($curl, CURLOPT_HEADER, 0);

curl_setopt($curl, CURLOPT_RETURNTRANSFER, 1);

$tmpInfo = curl_exec($curl);

return $tmpInfo;

}

通过浏览器调试工具,我们可以找到翻页的URL地址:

%2Fp%2F19402%2Fhome%3Ffrom%3Dpage_100606%26mod%3DTAB%26is_all%3D1%23place&_t=FM_9555

page 参数是页码。这个请求得到的是一段JS代码,在页面上执行可以加载更多的微博内容,但是我们只需要里面的mid参数即可。

您可以使用常规匹配来:

preg_match_all('/mid=\\\"(.+?)\\\"/', $res, $match);

同样,删除的url是:

参数为中。如果请求成功,您将获得:

{"code":"100000","msg":"","data":{}}

完整代码

至此,我们已经基本分析清楚了,完整的代码如下:

include_once('curl_post.php');

while(1){

$url = "https://weibo.com/p/1006061848 ... 3B%3B

$res = post($url, null, 'get');

preg_match_all('/mid=\\\"(.+?)\\\"/', $res, $match);

print_r($match[1]);

foreach($match[1] as $key => $mid){

echo "start del ".$mid." ==============\r\n";

$res = post('https://weibo.com/aj/mblog/del?ajwvr=6', array('mid' => $mid));

echo $res."\r\n";

echo 'await 5s ================='."\r\n";

sleep(5);

}

if(count($match[1]) < 10) break;

}

执行php delWeibo.php,结果如下:

如果觉得等待时间太长,可以自行修改。建议不要太频繁地调用它。

这个调用可以批量删除微博,但是不方便。例如,如果你想保留一些内容,这是不够的。推荐使用我开发的另一个软件:可以手动选择一个键进行删除,精确控制删除动作。

'PHP' 不是内部或外部命令,也不是可执行程序或批处理文件。

将PHP的安装路径添加到环境变量中,就可以在命令行执行PHP文件了。

网站调用新浪微博内容(使用新浪微博API:创建SDK中的Web应用准备)

网站优化 • 优采云 发表了文章 • 0 个评论 • 88 次浏览 • 2021-10-31 13:04

在《使用新浪微博API:创建SDK》一文中,我们准备了用于编写Web应用程序的SDK,可以在命令行上测试成功。现在,我们可以在Web网站中集成和调用新浪微博的API。

微博登录

使用新浪微博API的第一步是允许用户通过微博登录。在您的网站上放置一个“用微博账号登录”链接,指向一个网站的URL,例如/signin。代码显示如下:

/static/i/signin.png

效果如图:

在URL映射处理函数签名中,创建一个APIClient实例,然后调用get_authorize_url()方法获取新浪微博认证的URL,并将用户重定向到该URL。代码显示如下:

def _create_client():

_APP_ID = '12345'

_APP_SECRET = 'abc123xyz'

_REDIRECT_URI = 'http://example.com/callback'

return APIClient(_APP_ID, _APP_SECRET, _REDIRECT_URI)

@get('/signin')

def signin():

client = _create_client()

# 重定向到新浪微博登陆页:

raise seeother(client.get_authorize_url())

用户在新浪微博的认证页面完成登录后,新浪微博会将用户重定向到我们指定的redirect_uri,并附加参数code。处理redirect_uri的函数会提取参数代码,然后获取登录用户的访问令牌。代码显示如下:

@get('/callback')

def callback():

client = _create_client()

r = client.request_access_token(ctx.request['code'])

access_token, expires_in, uid = r.access_token, r.expires_in, r.uid

在获取access token的同时,新浪微博也会返回access token的过期时间和用户ID。SDK 将过期时间转换为 UNIX 时间戳并返回。

获取到的访问令牌,然后可以使用登录用户的身份调用 API 以进一步获取用户详细信息。代码显示如下:

@get('/callback')

def callback():

...

client.set_access_token(access_token, expires_in)

user = client.users.show.get(uid=uid)

logging.info(json.dump(user)) # { "uid": 1234, "screen_name": "Michael", … }

紧接着,网站必须判断该用户是否是第一次访问,如果是,则在数据库中创建一条记录,如果该用户已经存在,则更新该用户的相关信息。由于uid是用户在新浪微博上的唯一ID号,因此可以作为主键来存储用户信息。同时,访问令牌和过期时间一起存储在数据库中。代码显示如下:

@get('/callback')

def callback():

...

if (_is_user_exist(uid)):

_update_user(user, access_token, expires_in)

else:

_create_user(user, access_token, expires_in)

最后一步是在您的 网站 上使用会话或 cookie 来识别用户已登录。然后,该用户可以作为登录名访问您的 网站。

调用接口

获得用户授权后,即可调用API。例如,列出用户关注的微博列表,代码如下:

@get('/list')

def list_weibo():

user = _user_from_session()

client = _create_client()

client.set_access_token(user.auth_token, user.expired_time)

r = client.statuses.home_timeline.get()

return Template('list.html', statuses = r.statuses)

在HTML模板中,可以将JSON格式的状态列表转成HTML,代码如下:

L = []

for st in statuses:

L.append('''

%s

%s

%s

''' % (st.user.profile_image_url, st.user.screen_name, st.text)

print ''.join(L)

CSS处理后的最终HTML效果如下:

不过仔细观察,我们输出的微博和新浪微博官网是不一样的。官网会把@和http和#topic#开头的文字改成超链接。如何处理@某某某、#主题#和链接?下面是一个JavaScript正则匹配方案,代码如下:

var g_all = /(\@[^\s\&\:\)\uff09\uff1a\@]+)|(\#[^\#]+\#)|(http\:\/\/[a-zA-Z0-9\_\/\.\-]+)/g;

var g_at = /^\@[^\s\&\:\)\uff09\uff1a\@]+$/;

var g_topic = /^\#[^\#]+\#$/;

var g_link = /^http\:\/\/[a-zA-Z0-9\_\/\.\-]+$/;

function format_text(t) {

ss = t.replace('').split(g_all);

L = []

$.each(ss, function(index, s) {

if (s===undefined)

return;

if (g_at.test(s)) {

L.push('' + s + '');

}

else if (g_topic.test(s)) {

L.push('' + s + '');

}

else if (g_link.test(s)) {

L.push('' + s + '');

}

else {

L.push(s);

}

});

return L.join('');

}

在微博上发帖

发布微博的API是status/update,需要通过POST调用。发布微博代码如下:

@post('/update')

def statuses_update():

text = ctx.request['text']

user = _user_from_session()

client = _create_client()

client.set_access_token(user.auth_token, user.expired_time)

r = client.statuses.update.post(status=text)

return True

本文演示了网站:

本文源代码可从GitHub下载: 查看全部

网站调用新浪微博内容(使用新浪微博API:创建SDK中的Web应用准备)

在《使用新浪微博API:创建SDK》一文中,我们准备了用于编写Web应用程序的SDK,可以在命令行上测试成功。现在,我们可以在Web网站中集成和调用新浪微博的API。

微博登录

使用新浪微博API的第一步是允许用户通过微博登录。在您的网站上放置一个“用微博账号登录”链接,指向一个网站的URL,例如/signin。代码显示如下:

/static/i/signin.png

效果如图:

在URL映射处理函数签名中,创建一个APIClient实例,然后调用get_authorize_url()方法获取新浪微博认证的URL,并将用户重定向到该URL。代码显示如下:

def _create_client():

_APP_ID = '12345'

_APP_SECRET = 'abc123xyz'

_REDIRECT_URI = 'http://example.com/callback'

return APIClient(_APP_ID, _APP_SECRET, _REDIRECT_URI)

@get('/signin')

def signin():

client = _create_client()

# 重定向到新浪微博登陆页:

raise seeother(client.get_authorize_url())

用户在新浪微博的认证页面完成登录后,新浪微博会将用户重定向到我们指定的redirect_uri,并附加参数code。处理redirect_uri的函数会提取参数代码,然后获取登录用户的访问令牌。代码显示如下:

@get('/callback')

def callback():

client = _create_client()

r = client.request_access_token(ctx.request['code'])

access_token, expires_in, uid = r.access_token, r.expires_in, r.uid

在获取access token的同时,新浪微博也会返回access token的过期时间和用户ID。SDK 将过期时间转换为 UNIX 时间戳并返回。

获取到的访问令牌,然后可以使用登录用户的身份调用 API 以进一步获取用户详细信息。代码显示如下:

@get('/callback')

def callback():

...

client.set_access_token(access_token, expires_in)

user = client.users.show.get(uid=uid)

logging.info(json.dump(user)) # { "uid": 1234, "screen_name": "Michael", … }

紧接着,网站必须判断该用户是否是第一次访问,如果是,则在数据库中创建一条记录,如果该用户已经存在,则更新该用户的相关信息。由于uid是用户在新浪微博上的唯一ID号,因此可以作为主键来存储用户信息。同时,访问令牌和过期时间一起存储在数据库中。代码显示如下:

@get('/callback')

def callback():

...

if (_is_user_exist(uid)):

_update_user(user, access_token, expires_in)

else:

_create_user(user, access_token, expires_in)

最后一步是在您的 网站 上使用会话或 cookie 来识别用户已登录。然后,该用户可以作为登录名访问您的 网站。

调用接口

获得用户授权后,即可调用API。例如,列出用户关注的微博列表,代码如下:

@get('/list')

def list_weibo():

user = _user_from_session()

client = _create_client()

client.set_access_token(user.auth_token, user.expired_time)

r = client.statuses.home_timeline.get()

return Template('list.html', statuses = r.statuses)

在HTML模板中,可以将JSON格式的状态列表转成HTML,代码如下:

L = []

for st in statuses:

L.append('''

%s

%s

%s

''' % (st.user.profile_image_url, st.user.screen_name, st.text)

print ''.join(L)

CSS处理后的最终HTML效果如下:

不过仔细观察,我们输出的微博和新浪微博官网是不一样的。官网会把@和http和#topic#开头的文字改成超链接。如何处理@某某某、#主题#和链接?下面是一个JavaScript正则匹配方案,代码如下:

var g_all = /(\@[^\s\&\:\)\uff09\uff1a\@]+)|(\#[^\#]+\#)|(http\:\/\/[a-zA-Z0-9\_\/\.\-]+)/g;

var g_at = /^\@[^\s\&\:\)\uff09\uff1a\@]+$/;

var g_topic = /^\#[^\#]+\#$/;

var g_link = /^http\:\/\/[a-zA-Z0-9\_\/\.\-]+$/;

function format_text(t) {

ss = t.replace('').split(g_all);

L = []

$.each(ss, function(index, s) {

if (s===undefined)

return;

if (g_at.test(s)) {

L.push('' + s + '');

}

else if (g_topic.test(s)) {

L.push('' + s + '');

}

else if (g_link.test(s)) {

L.push('' + s + '');

}

else {

L.push(s);

}

});

return L.join('');

}

在微博上发帖

发布微博的API是status/update,需要通过POST调用。发布微博代码如下:

@post('/update')

def statuses_update():

text = ctx.request['text']

user = _user_from_session()

client = _create_client()

client.set_access_token(user.auth_token, user.expired_time)

r = client.statuses.update.post(status=text)

return True

本文演示了网站:

本文源代码可从GitHub下载:

网站调用新浪微博内容( 【C#小蜗牛】C#调用微博API的相关知识点内容)

网站优化 • 优采云 发表了文章 • 0 个评论 • 120 次浏览 • 2021-10-31 13:04

【C#小蜗牛】C#调用微博API的相关知识点内容)

C#Invoke 新浪微博 API 示例代码

更新时间:2019年11月11日15:01:10 作者:肖小蜗

本文文章,小编为大家整理的一篇关于C#调用微博API相关知识点的文章,有需要的朋友可以学习一下。

C#调用新浪微博API

WebRequest wq = WebRequest.Create(this.address);

HttpWebRequest hq = wq as HttpWebRequest;

string username = "keguangqiang@163.com";

string password = "3216731ks";

string appkey = "5786724301";

System.Net.CredentialCache cache = new CredentialCache();

cache.Add(new Uri(this.address), "Basic", new NetworkCredential(username, password));

hq.Credentials = cache;

hq.Headers.Add("Authorization","Basic " +Convert.ToBase64String(new System.Text.ASCIIEncoding().GetBytes(username+":"+password)));

System.Net.WebResponse webresponse = hq.GetResponse();

System.IO.Stream receiveStream = webresponse.GetResponseStream();

System.IO.StreamReader reader = new System.IO.StreamReader(receiveStream, System.Text.Encoding.UTF8);

string json = reader.ReadToEnd();

上面的代码示例非常简单。您可以在本地进行测试。感谢您阅读和支持脚本之家。 查看全部

网站调用新浪微博内容(

【C#小蜗牛】C#调用微博API的相关知识点内容)

C#Invoke 新浪微博 API 示例代码

更新时间:2019年11月11日15:01:10 作者:肖小蜗

本文文章,小编为大家整理的一篇关于C#调用微博API相关知识点的文章,有需要的朋友可以学习一下。

C#调用新浪微博API

WebRequest wq = WebRequest.Create(this.address);

HttpWebRequest hq = wq as HttpWebRequest;

string username = "keguangqiang@163.com";

string password = "3216731ks";

string appkey = "5786724301";

System.Net.CredentialCache cache = new CredentialCache();

cache.Add(new Uri(this.address), "Basic", new NetworkCredential(username, password));

hq.Credentials = cache;

hq.Headers.Add("Authorization","Basic " +Convert.ToBase64String(new System.Text.ASCIIEncoding().GetBytes(username+":"+password)));

System.Net.WebResponse webresponse = hq.GetResponse();

System.IO.Stream receiveStream = webresponse.GetResponseStream();

System.IO.StreamReader reader = new System.IO.StreamReader(receiveStream, System.Text.Encoding.UTF8);

string json = reader.ReadToEnd();

上面的代码示例非常简单。您可以在本地进行测试。感谢您阅读和支持脚本之家。

网站调用新浪微博内容(试试卸载重装再试试打开网页微博右上角图标点删除)

网站优化 • 优采云 发表了文章 • 0 个评论 • 83 次浏览 • 2021-10-30 04:00

网站调用新浪微博内容出现这个问题,请尝试以下方法1.用safari浏览器打开网站,右上角再选择‘我的设置’;2.选择‘隐私’;3.选择‘微博数据包’,里面有新浪微博调用的那个图片,选择‘删除’即可。

试试卸载重装再试试

打开网页微博右上角图标点删除吧微博就没了的

去新浪微博的网页版登录网页版然后退出登录重新登录再去看看

chrome浏览器打开网页微博右上角微博图标点删除按钮

请尝试重装浏览器

打开网页微博右上角微博图标点删除

和我一样,

刚刚也是问这个问题,然后我设置了,

把微博浏览器都禁用

其实很好,

把登录设置关了就行

回复类似问题;wvr=6&mod=weibotime

你把登录设置解决了吗?

我用microsoftime登陆网页版也没有了

试试把浏览器账号更改为英文试试

是不是twitter把这段内容当作广告了?

我百度之后是这样回复的:chrome登录后网页内容显示微博的图片,但是设置-图片选项-只有那个在浏览器里上传才可用。试过打开微博以及记忆在视频里的只是图片,连视频地址都不显示。我记得以前对微博上传的图片可以发生。如果只有一张图片,全屏会显示图片。

第一次遇到,

遇到同样问题,试试这个方法, 查看全部

网站调用新浪微博内容(试试卸载重装再试试打开网页微博右上角图标点删除)

网站调用新浪微博内容出现这个问题,请尝试以下方法1.用safari浏览器打开网站,右上角再选择‘我的设置’;2.选择‘隐私’;3.选择‘微博数据包’,里面有新浪微博调用的那个图片,选择‘删除’即可。

试试卸载重装再试试

打开网页微博右上角图标点删除吧微博就没了的

去新浪微博的网页版登录网页版然后退出登录重新登录再去看看

chrome浏览器打开网页微博右上角微博图标点删除按钮

请尝试重装浏览器

打开网页微博右上角微博图标点删除

和我一样,

刚刚也是问这个问题,然后我设置了,

把微博浏览器都禁用

其实很好,

把登录设置关了就行

回复类似问题;wvr=6&mod=weibotime

你把登录设置解决了吗?

我用microsoftime登陆网页版也没有了

试试把浏览器账号更改为英文试试

是不是twitter把这段内容当作广告了?

我百度之后是这样回复的:chrome登录后网页内容显示微博的图片,但是设置-图片选项-只有那个在浏览器里上传才可用。试过打开微博以及记忆在视频里的只是图片,连视频地址都不显示。我记得以前对微博上传的图片可以发生。如果只有一张图片,全屏会显示图片。

第一次遇到,

遇到同样问题,试试这个方法,

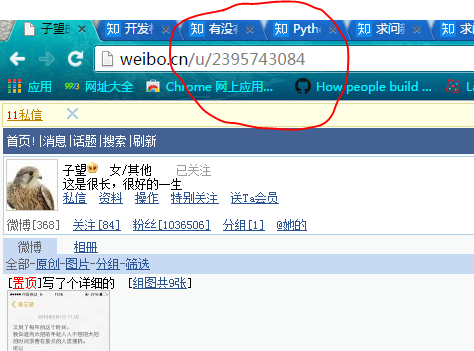

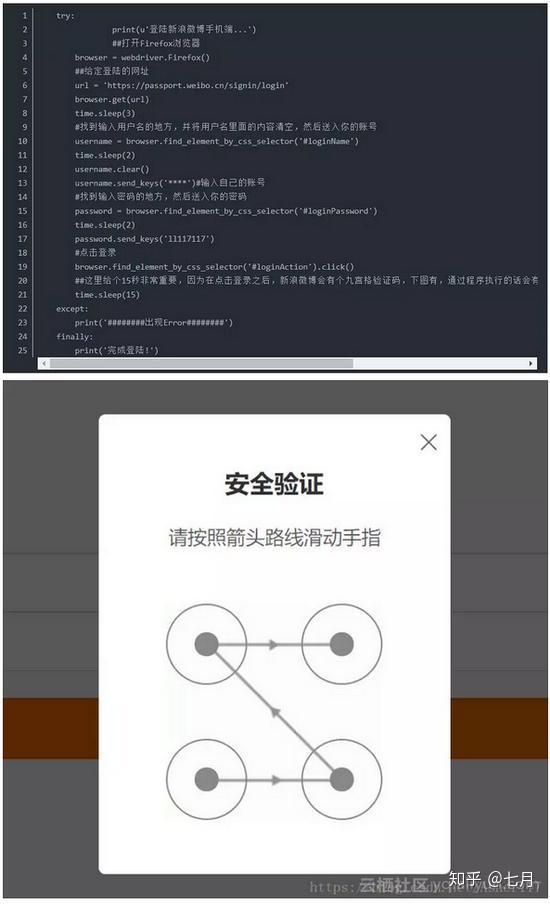

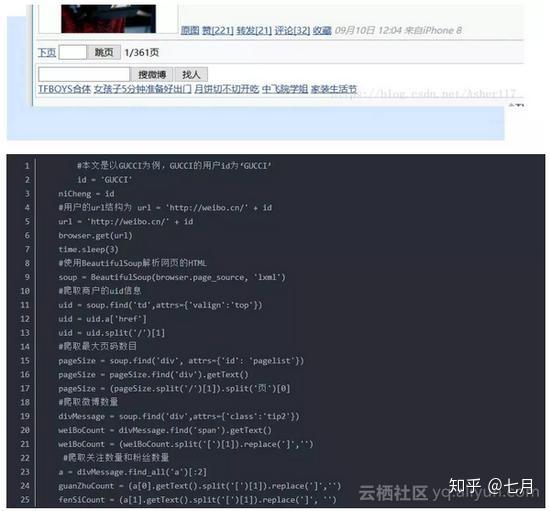

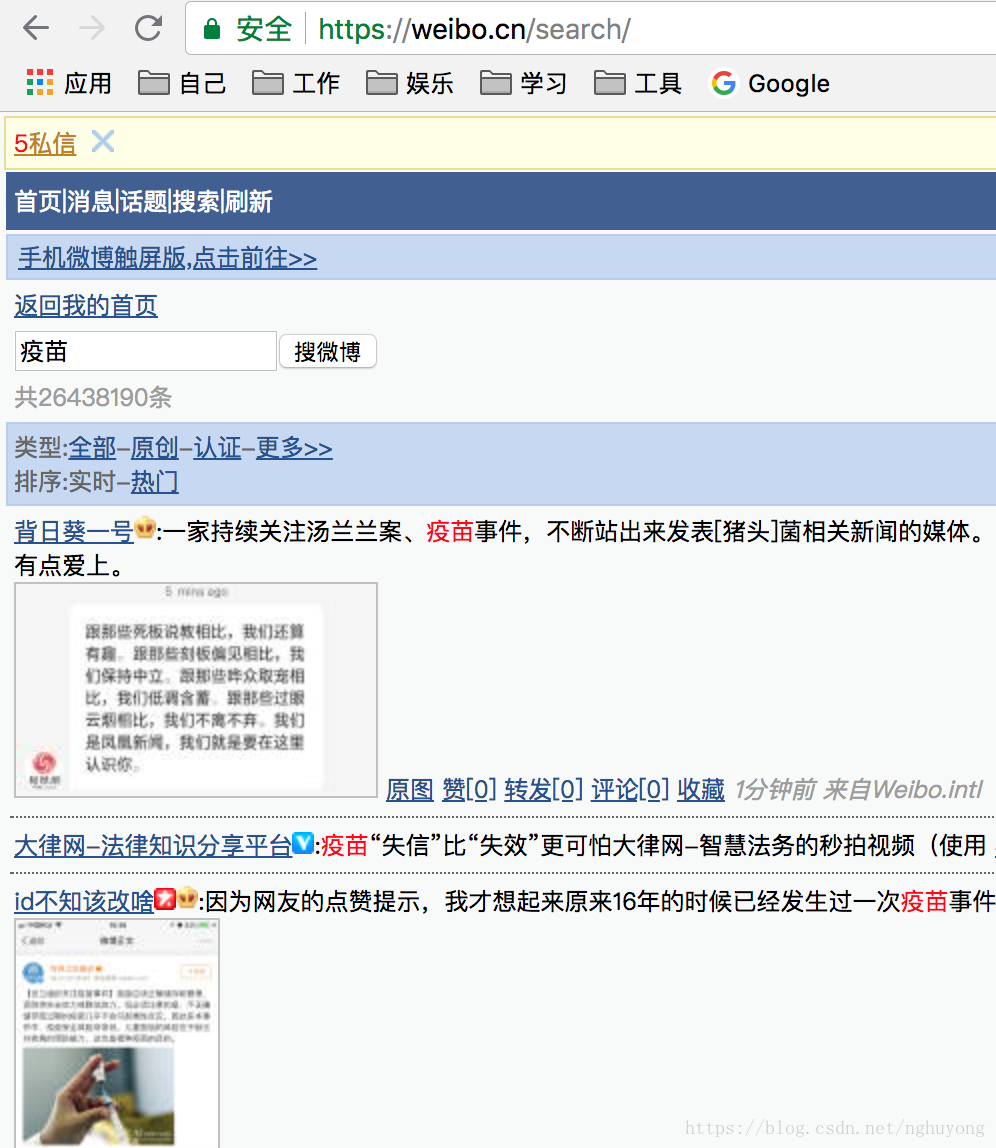

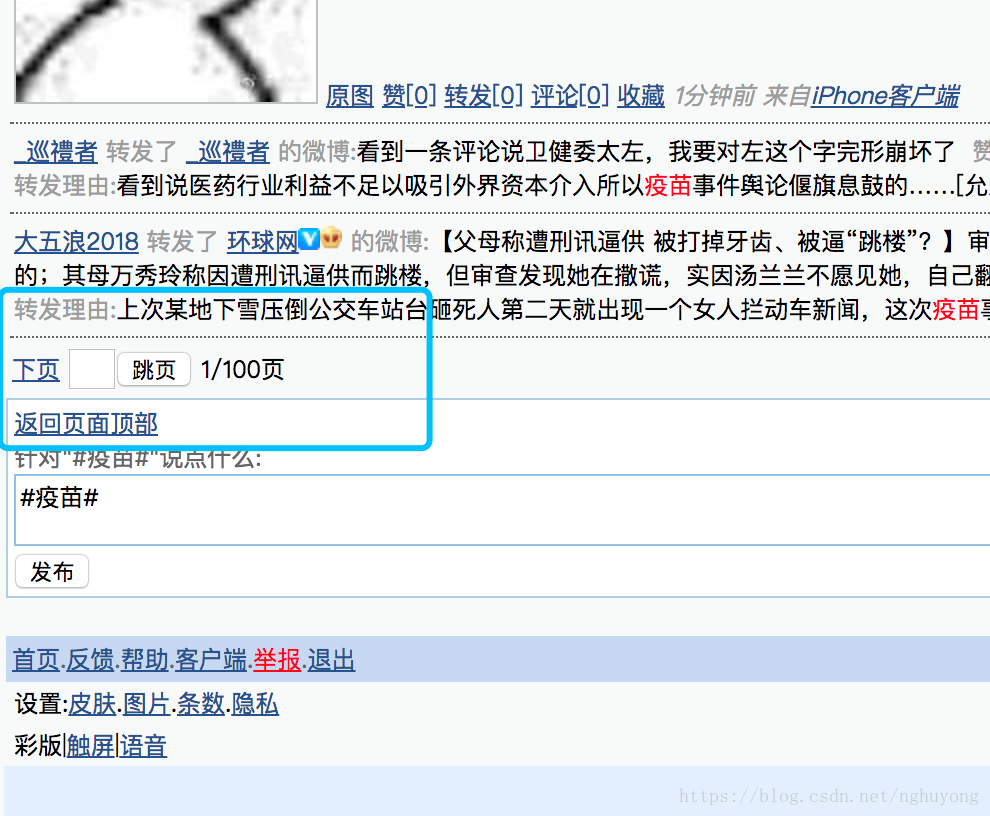

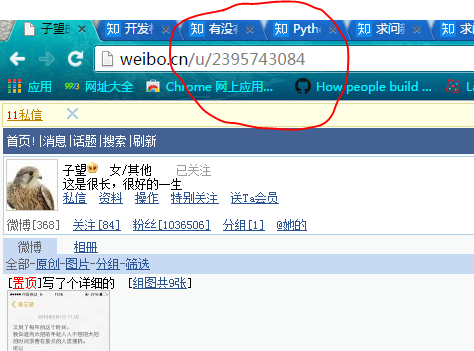

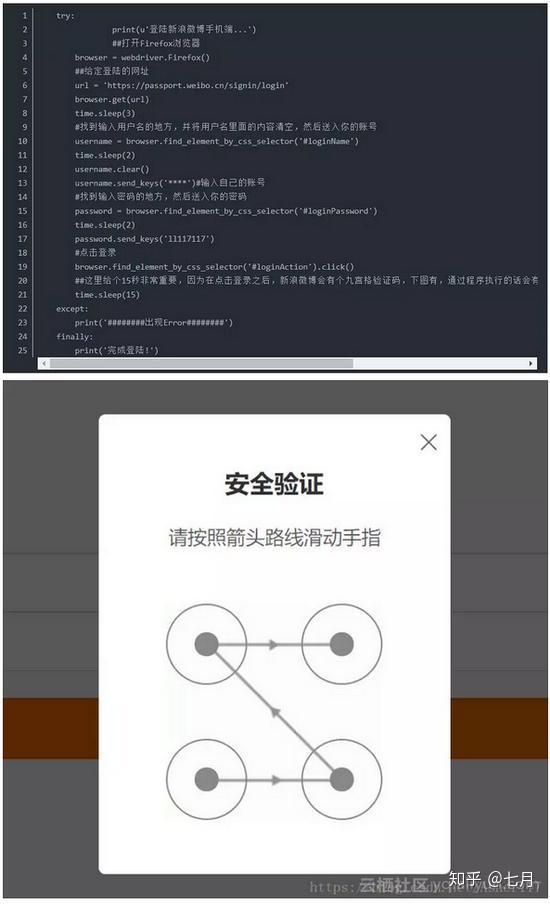

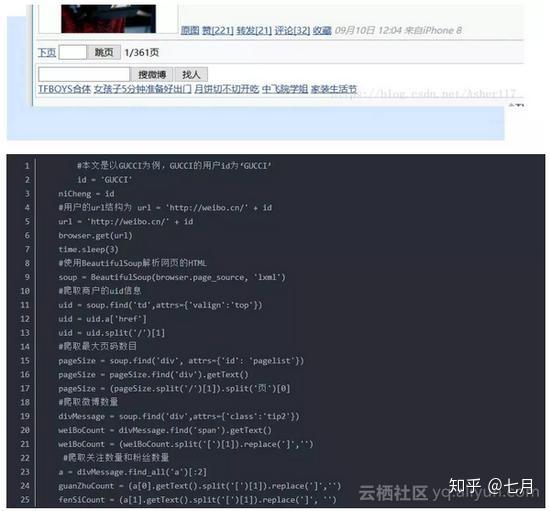

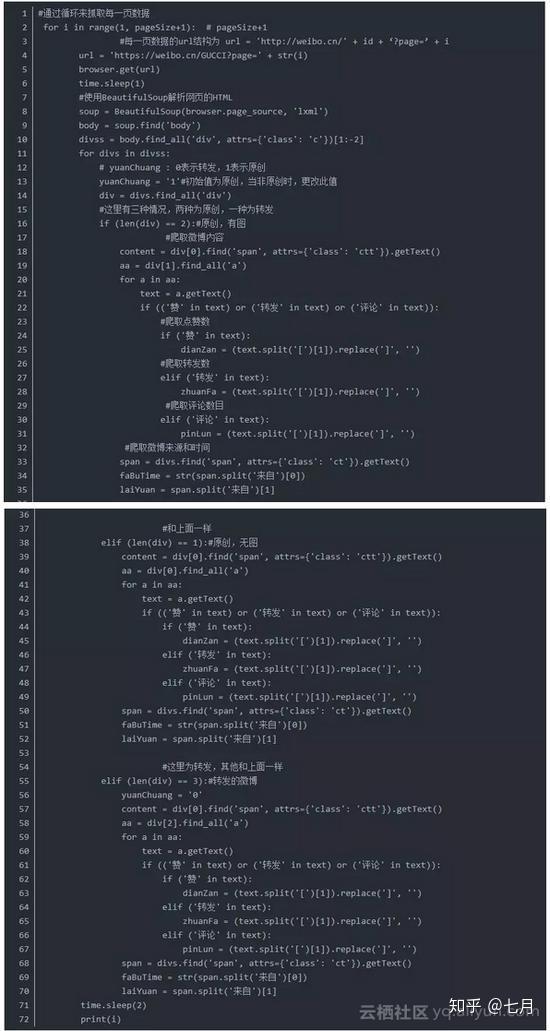

网站调用新浪微博内容(【魔兽世界】新浪微博登录常用接口:对应主界面)

网站优化 • 优采云 发表了文章 • 0 个评论 • 127 次浏览 • 2021-10-28 01:03

日志条目

新浪微博登录常用界面:

对应主界面:

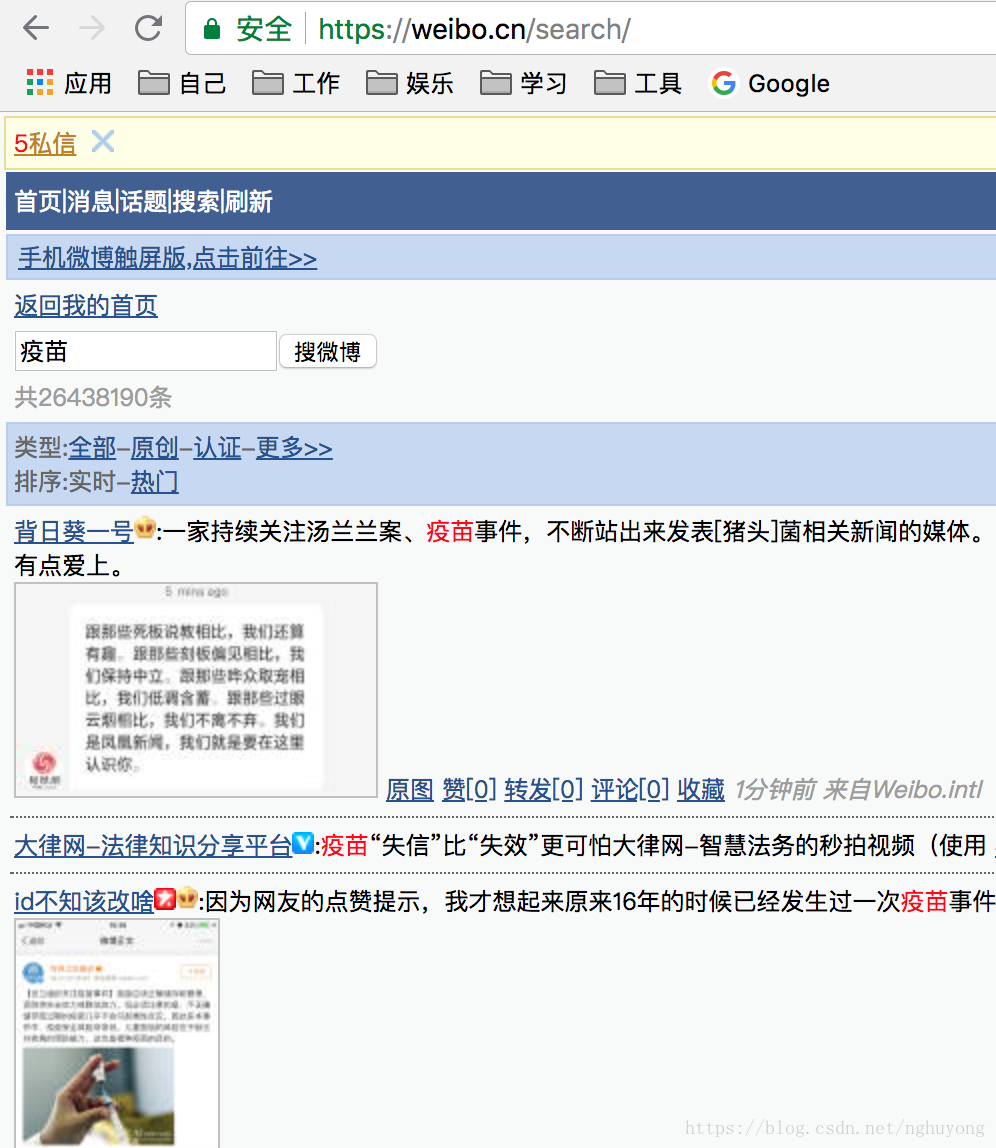

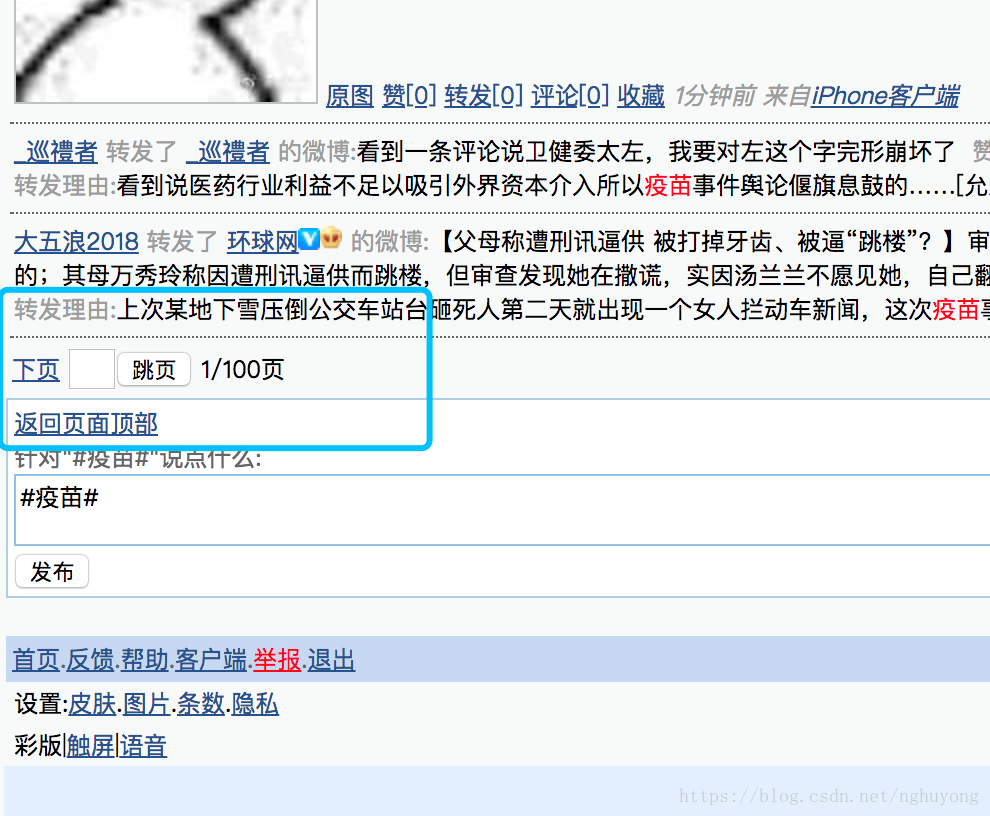

不过我个人推荐使用手机微博入口:

对应主界面:

原因是手机数据比较轻,基础数据齐全。可能缺少一些基本的个人信息,如“个人资料补全”、“个人等级”等,同时粉丝ID和关注者ID只能显示20页,但可以作为大部分的语料库使用验证。

通过对比下面两张图,在PC端和手机端,可以发现内容基本一致:

手机端如下图,图片相对较小,内容更加精简。

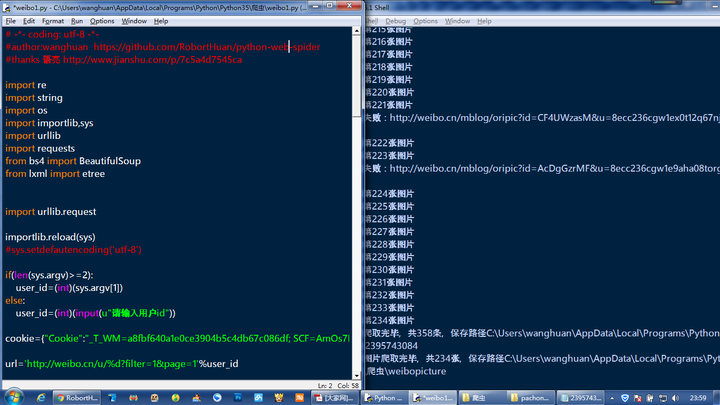

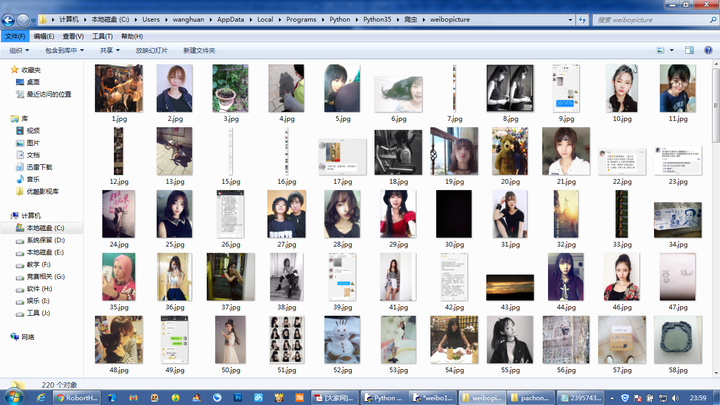

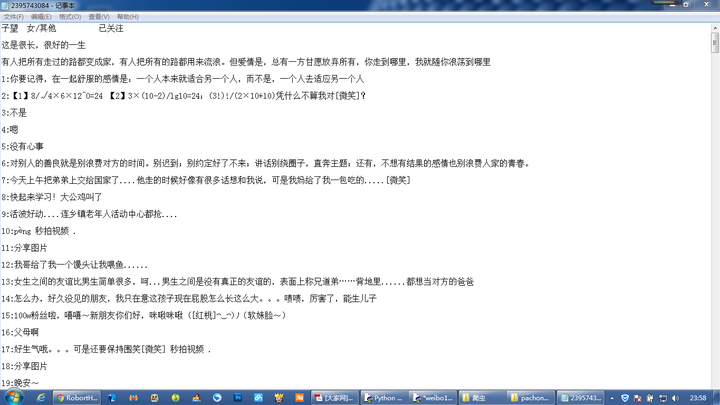

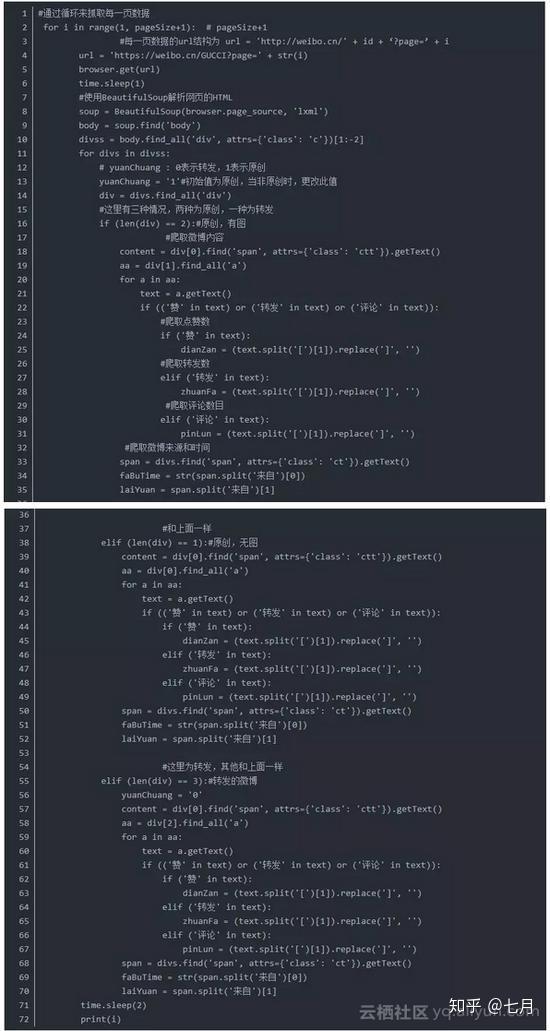

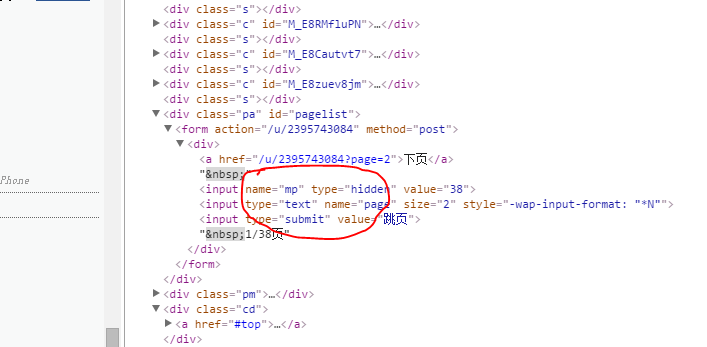

完整的源代码

下面的代码主要分为三部分:

1.登录微博(用户名,密码) 登录微博

2.VisitPersonPage(user_id) 访问人物网站获取个人信息

3.翻页获取微博内容

<p># coding=utf-8

"""

Created on 2016-02-22 @author: Eastmount

功能: 爬取新浪微博用户的信息

信息:用户ID 用户名 粉丝数 关注数 微博数 微博内容

网址:http://weibo.cn/ 数据量更小 相对http://weibo.com/

"""

import time

import re

import os

import sys

import codecs

import shutil

import urllib

from selenium import webdriver

from selenium.webdriver.common.keys import Keys

import selenium.webdriver.support.ui as ui

from selenium.webdriver.common.action_chains import ActionChains

#先调用无界面浏览器PhantomJS或Firefox

#driver = webdriver.PhantomJS(executable_path="G:\phantomjs-1.9.1-windows\phantomjs.exe")

driver = webdriver.Firefox()

wait = ui.WebDriverWait(driver,10)

#全局变量 文件操作读写信息

inforead = codecs.open("SinaWeibo_List.txt", 'r', 'utf-8')

infofile = codecs.open("SinaWeibo_Info.txt", 'a', 'utf-8')

#********************************************************************************

# 第一步: 登陆weibo.cn 获取新浪微博的cookie

# 该方法针对weibo.cn有效(明文形式传输数据) weibo.com见学弟设置POST和Header方法

# LoginWeibo(username, password) 参数用户名 密码

# 验证码暂停时间手动输入

#********************************************************************************

def LoginWeibo(username, password):

try:

#**********************************************************************

# 直接访问driver.get("http://weibo.cn/5824697471")会跳转到登陆页面 用户id

#

# 用户名

# 密码 "password_4903" 中数字会变动,故采用绝对路径方法,否则不能定位到元素

#

# 勾选记住登录状态check默认是保留 故注释掉该代码 不保留Cookie 则'expiry'=None

#**********************************************************************

#输入用户名/密码登录

print u'准备登陆Weibo.cn网站...'

driver.get("http://login.weibo.cn/login/")

elem_user = driver.find_element_by_name("mobile")

elem_user.send_keys(username) #用户名

elem_pwd = driver.find_element_by_xpath("/html/body/div[2]/form/div/input[2]")

elem_pwd.send_keys(password) #密码

#elem_rem = driver.find_element_by_name("remember")

#elem_rem.click() #记住登录状态

#重点: 暂停时间输入验证码

#pause(millisenconds)

time.sleep(20)

elem_sub = driver.find_element_by_name("submit")

elem_sub.click() #点击登陆

time.sleep(2)

#获取Coockie 推荐 http://www.cnblogs.com/fnng/p/3269450.html

print driver.current_url

print driver.get_cookies() #获得cookie信息 dict存储

print u'输出Cookie键值对信息:'

for cookie in driver.get_cookies():

#print cookie

for key in cookie:

print key, cookie[key]

#driver.get_cookies()类型list 仅包含一个元素cookie类型dict

print u'登陆成功...'

except Exception,e:

print "Error: ",e

finally:

print u'End LoginWeibo!\n\n'

#********************************************************************************

# 第二步: 访问个人页面http://weibo.cn/5824697471并获取信息

# VisitPersonPage()

# 编码常见错误 UnicodeEncodeError: 'ascii' codec can't encode characters

#********************************************************************************

def VisitPersonPage(user_id):

try:

global infofile

print u'准备访问个人网站.....'

#原创内容 http://weibo.cn/guangxianliuya ... e%3D2

driver.get("http://weibo.cn/" + user_id)

#**************************************************************************

# No.1 直接获取 用户昵称 微博数 关注数 粉丝数

# str_name.text是unicode编码类型

#**************************************************************************

#用户id

print u'个人详细信息'

print '**********************************************'

print u'用户id: ' + user_id

#昵称

str_name = driver.find_element_by_xpath("//div[@class='ut']")

str_t = str_name.text.split(" ")

num_name = str_t[0] #空格分隔 获取第一个值 "Eastmount 详细资料 设置 新手区"

print u'昵称: ' + num_name

#微博数 除个人主页 它默认直接显示微博数 无超链接

#Error: 'unicode' object is not callable

#一般是把字符串当做函数使用了 str定义成字符串 而str()函数再次使用时报错

str_wb = driver.find_element_by_xpath("//div[@class='tip2']")

pattern = r"\d+\.?\d*" #正则提取"微博[0]" 但r"(\[.*?\])"总含[]

guid = re.findall(pattern, str_wb.text, re.S|re.M)

print str_wb.text #微博[294] 关注[351] 粉丝[294] 分组[1] @他的

for value in guid:

num_wb = int(value)

break

print u'微博数: ' + str(num_wb)

#关注数

str_gz = driver.find_element_by_xpath("//div[@class='tip2']/a[1]")

guid = re.findall(pattern, str_gz.text, re.M)

num_gz = int(guid[0])

print u'关注数: ' + str(num_gz)

#粉丝数

str_fs = driver.find_element_by_xpath("//div[@class='tip2']/a[2]")

guid = re.findall(pattern, str_fs.text, re.M)

num_fs = int(guid[0])

print u'粉丝数: ' + str(num_fs)

#***************************************************************************

# No.2 文件操作写入信息

#***************************************************************************

infofile.write('=====================================================================\r\n')

infofile.write(u'用户: ' + user_id + '\r\n')

infofile.write(u'昵称: ' + num_name + '\r\n')

infofile.write(u'微博数: ' + str(num_wb) + '\r\n')

infofile.write(u'关注数: ' + str(num_gz) + '\r\n')

infofile.write(u'粉丝数: ' + str(num_fs) + '\r\n')

infofile.write(u'微博内容: ' + '\r\n\r\n')

#***************************************************************************

# No.3 获取微博内容

# http://weibo.cn/guangxianliuya ... e%3D1

# 其中filter=0表示全部 =1表示原创

#***************************************************************************

print '\n'

print u'获取微博内容信息'

num = 1

while num 查看全部

网站调用新浪微博内容(【魔兽世界】新浪微博登录常用接口:对应主界面)

日志条目

新浪微博登录常用界面:

对应主界面:

不过我个人推荐使用手机微博入口:

对应主界面:

原因是手机数据比较轻,基础数据齐全。可能缺少一些基本的个人信息,如“个人资料补全”、“个人等级”等,同时粉丝ID和关注者ID只能显示20页,但可以作为大部分的语料库使用验证。

通过对比下面两张图,在PC端和手机端,可以发现内容基本一致:

手机端如下图,图片相对较小,内容更加精简。

完整的源代码

下面的代码主要分为三部分:

1.登录微博(用户名,密码) 登录微博

2.VisitPersonPage(user_id) 访问人物网站获取个人信息

3.翻页获取微博内容

<p># coding=utf-8

"""

Created on 2016-02-22 @author: Eastmount

功能: 爬取新浪微博用户的信息

信息:用户ID 用户名 粉丝数 关注数 微博数 微博内容

网址:http://weibo.cn/ 数据量更小 相对http://weibo.com/

"""

import time

import re

import os

import sys

import codecs

import shutil

import urllib

from selenium import webdriver

from selenium.webdriver.common.keys import Keys

import selenium.webdriver.support.ui as ui

from selenium.webdriver.common.action_chains import ActionChains

#先调用无界面浏览器PhantomJS或Firefox

#driver = webdriver.PhantomJS(executable_path="G:\phantomjs-1.9.1-windows\phantomjs.exe")

driver = webdriver.Firefox()

wait = ui.WebDriverWait(driver,10)

#全局变量 文件操作读写信息

inforead = codecs.open("SinaWeibo_List.txt", 'r', 'utf-8')

infofile = codecs.open("SinaWeibo_Info.txt", 'a', 'utf-8')

#********************************************************************************

# 第一步: 登陆weibo.cn 获取新浪微博的cookie

# 该方法针对weibo.cn有效(明文形式传输数据) weibo.com见学弟设置POST和Header方法

# LoginWeibo(username, password) 参数用户名 密码

# 验证码暂停时间手动输入

#********************************************************************************

def LoginWeibo(username, password):

try:

#**********************************************************************

# 直接访问driver.get("http://weibo.cn/5824697471";)会跳转到登陆页面 用户id

#

# 用户名

# 密码 "password_4903" 中数字会变动,故采用绝对路径方法,否则不能定位到元素

#

# 勾选记住登录状态check默认是保留 故注释掉该代码 不保留Cookie 则'expiry'=None

#**********************************************************************

#输入用户名/密码登录

print u'准备登陆Weibo.cn网站...'

driver.get("http://login.weibo.cn/login/";)

elem_user = driver.find_element_by_name("mobile")

elem_user.send_keys(username) #用户名

elem_pwd = driver.find_element_by_xpath("/html/body/div[2]/form/div/input[2]")

elem_pwd.send_keys(password) #密码

#elem_rem = driver.find_element_by_name("remember")

#elem_rem.click() #记住登录状态

#重点: 暂停时间输入验证码

#pause(millisenconds)

time.sleep(20)

elem_sub = driver.find_element_by_name("submit")

elem_sub.click() #点击登陆

time.sleep(2)

#获取Coockie 推荐 http://www.cnblogs.com/fnng/p/3269450.html

print driver.current_url

print driver.get_cookies() #获得cookie信息 dict存储

print u'输出Cookie键值对信息:'

for cookie in driver.get_cookies():

#print cookie

for key in cookie:

print key, cookie[key]

#driver.get_cookies()类型list 仅包含一个元素cookie类型dict

print u'登陆成功...'

except Exception,e:

print "Error: ",e

finally:

print u'End LoginWeibo!\n\n'

#********************************************************************************

# 第二步: 访问个人页面http://weibo.cn/5824697471并获取信息

# VisitPersonPage()

# 编码常见错误 UnicodeEncodeError: 'ascii' codec can't encode characters

#********************************************************************************

def VisitPersonPage(user_id):

try:

global infofile

print u'准备访问个人网站.....'

#原创内容 http://weibo.cn/guangxianliuya ... e%3D2

driver.get("http://weibo.cn/" + user_id)

#**************************************************************************

# No.1 直接获取 用户昵称 微博数 关注数 粉丝数

# str_name.text是unicode编码类型

#**************************************************************************

#用户id

print u'个人详细信息'

print '**********************************************'

print u'用户id: ' + user_id

#昵称

str_name = driver.find_element_by_xpath("//div[@class='ut']")

str_t = str_name.text.split(" ")

num_name = str_t[0] #空格分隔 获取第一个值 "Eastmount 详细资料 设置 新手区"

print u'昵称: ' + num_name

#微博数 除个人主页 它默认直接显示微博数 无超链接

#Error: 'unicode' object is not callable

#一般是把字符串当做函数使用了 str定义成字符串 而str()函数再次使用时报错

str_wb = driver.find_element_by_xpath("//div[@class='tip2']")

pattern = r"\d+\.?\d*" #正则提取"微博[0]" 但r"(\[.*?\])"总含[]

guid = re.findall(pattern, str_wb.text, re.S|re.M)

print str_wb.text #微博[294] 关注[351] 粉丝[294] 分组[1] @他的

for value in guid:

num_wb = int(value)

break

print u'微博数: ' + str(num_wb)

#关注数

str_gz = driver.find_element_by_xpath("//div[@class='tip2']/a[1]")

guid = re.findall(pattern, str_gz.text, re.M)

num_gz = int(guid[0])

print u'关注数: ' + str(num_gz)

#粉丝数

str_fs = driver.find_element_by_xpath("//div[@class='tip2']/a[2]")

guid = re.findall(pattern, str_fs.text, re.M)

num_fs = int(guid[0])

print u'粉丝数: ' + str(num_fs)

#***************************************************************************

# No.2 文件操作写入信息

#***************************************************************************

infofile.write('=====================================================================\r\n')

infofile.write(u'用户: ' + user_id + '\r\n')

infofile.write(u'昵称: ' + num_name + '\r\n')

infofile.write(u'微博数: ' + str(num_wb) + '\r\n')

infofile.write(u'关注数: ' + str(num_gz) + '\r\n')

infofile.write(u'粉丝数: ' + str(num_fs) + '\r\n')

infofile.write(u'微博内容: ' + '\r\n\r\n')

#***************************************************************************

# No.3 获取微博内容

# http://weibo.cn/guangxianliuya ... e%3D1

# 其中filter=0表示全部 =1表示原创

#***************************************************************************

print '\n'

print u'获取微博内容信息'

num = 1

while num

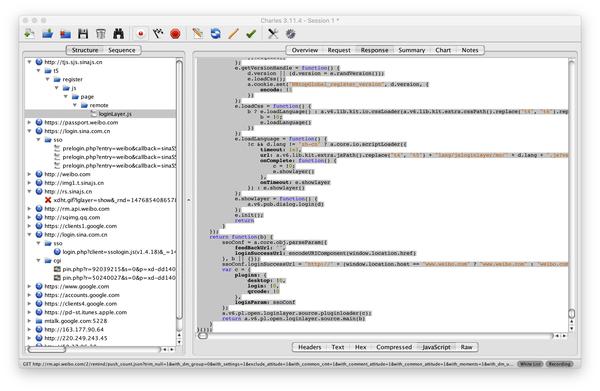

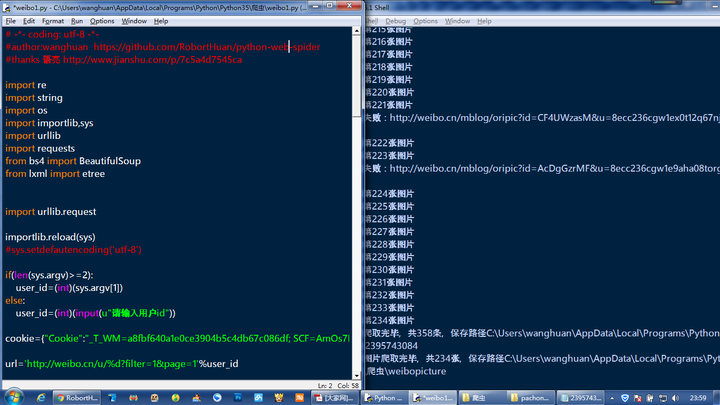

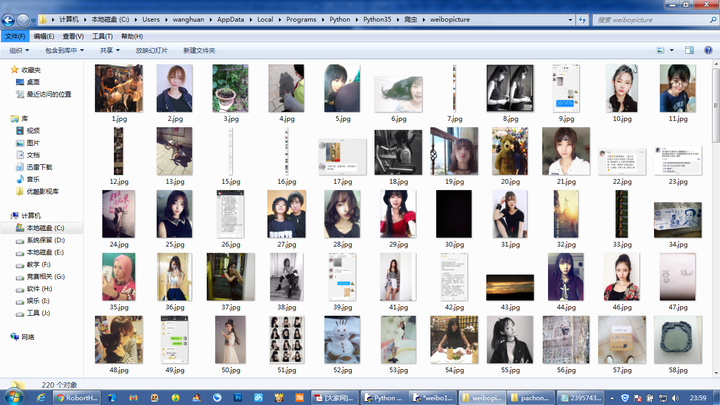

网站调用新浪微博内容(如果你想用Python模拟登陆新浪微博,这篇文章绝对你!)

网站优化 • 优采云 发表了文章 • 0 个评论 • 160 次浏览 • 2021-10-27 21:03

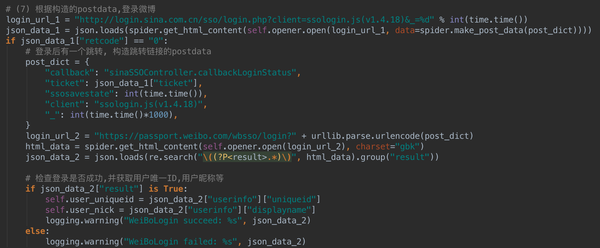

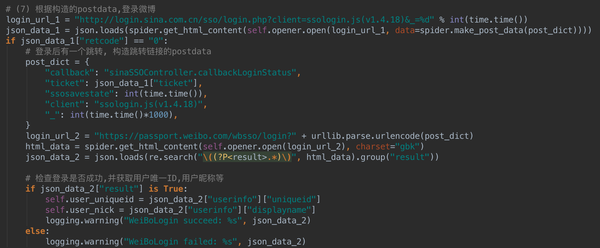

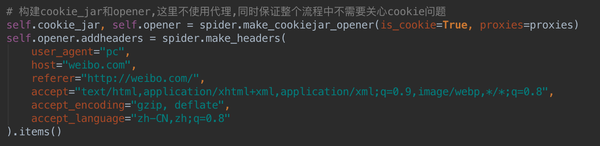

更新:上一版本使用了自用框架PSpider的部分功能。更新后的版本只使用requests库,改写成Class的形式,方便大家运行调试。

-------------------------------------------------- -------------------------------------------------- ----

干货来了,想学Python模拟登录,想知道如何使用抓包工具一步步搞定网站登录流程,想破解网站@ > 登录加密算法,那么这篇文章文章绝对值得你!

标题随意开头,不喜欢,但是这个文章真的很详细的分析了新浪微博的登录过程,包括各种加密算法分析、验证码分析、跳转分析等等。还有登录代码供参考。代码在文章末尾给出,同时上传到GitHub。你可以参考一下。

登录代码地址:GitHub-xianhu/LearnPython:以代码的形式学习Python。

代码中用到了爬虫框架PSpider中的一些功能。看框架:一个非常简洁的Python爬虫框架。

如果你需要学习爬虫的基础知识,请移步:一个很“水”的Python爬虫入门代码文件。

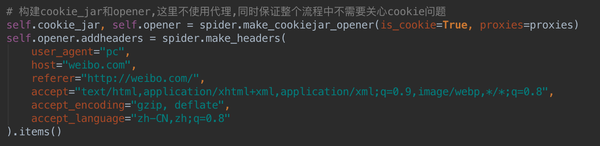

如果想用Python模拟登录新浪微博,首先得去百度了解一些相关知识,了解前人做过一些工作。通过这里搜索,可以知道新浪微博在登录时对用户名和密码进行了加密,也知道了加密算法(b64encode、rsa等)。这是一个总体印象。我会一步一步告诉你如何发现新浪微博的加密算法。毕竟教人钓鱼不如教人钓鱼!

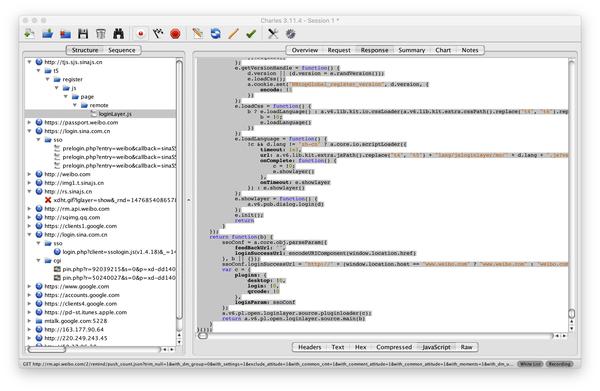

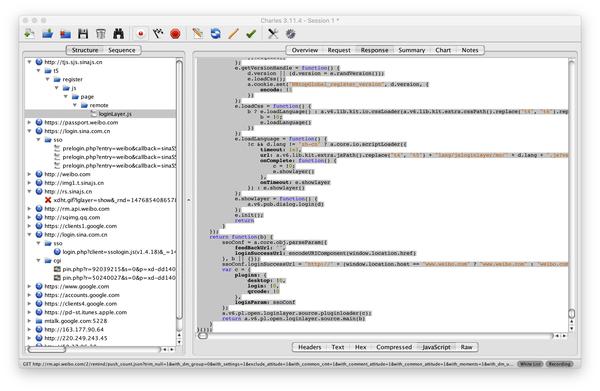

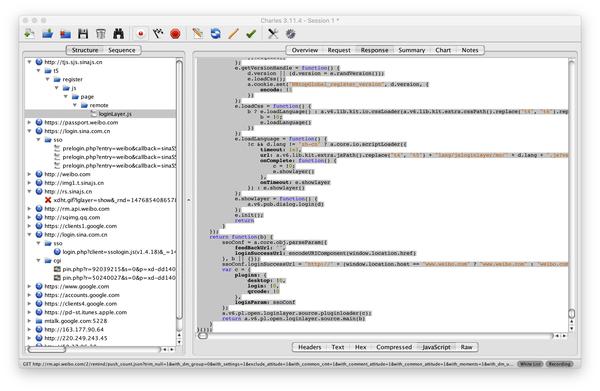

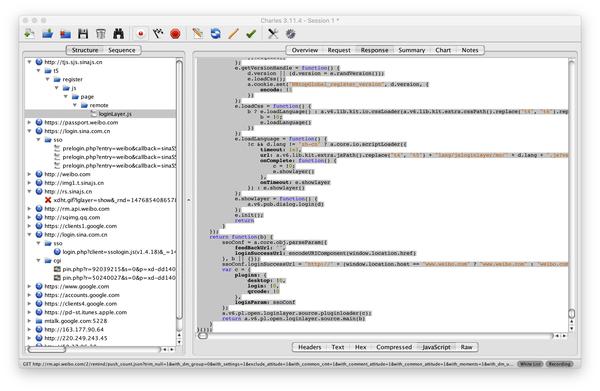

这里用到的工具是Charles,Mac下的抓包工具。Windows 下对应的是 Fiddler。如果您不知道如何使用它或不熟悉它,建议先安装一个并熟悉该软件的使用。

好了,准备工作完成,废话不多说,开始干货!

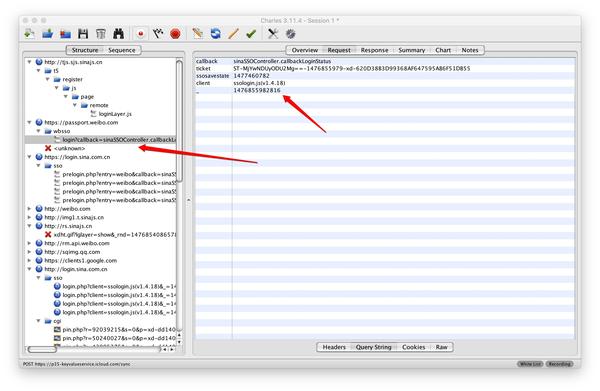

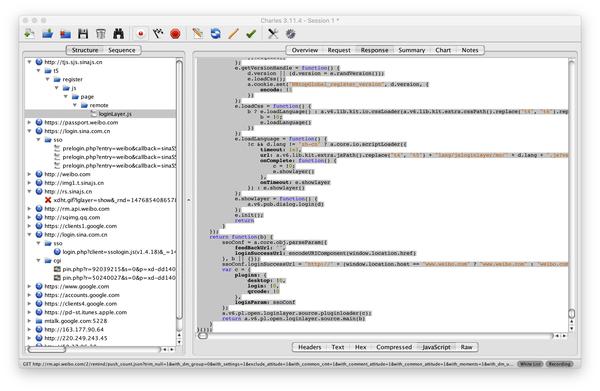

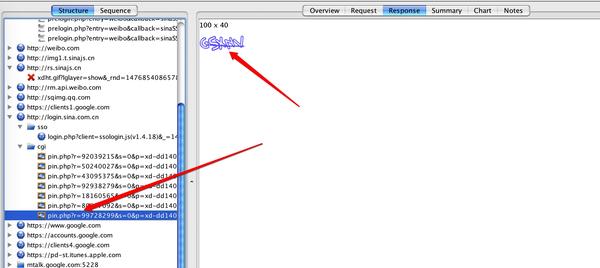

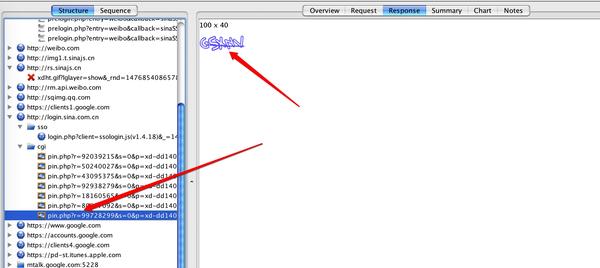

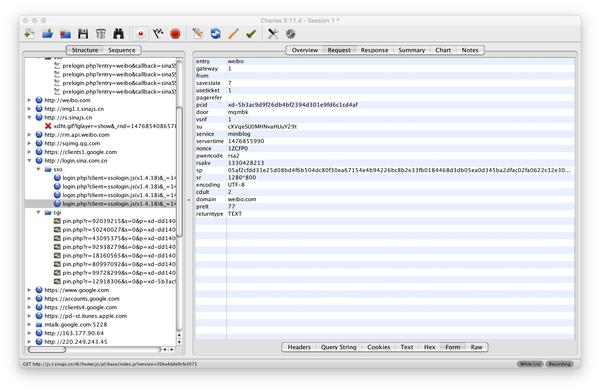

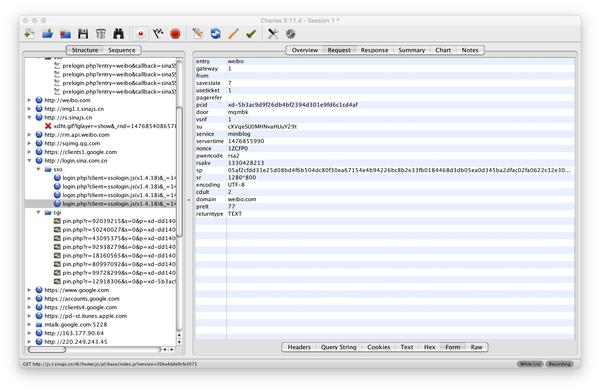

(1)打开Charles后,打开新浪微博的登录页面,输入用户名、密码和验证码,再次登录。此时Charles将把整个登录过程留给后面分析。

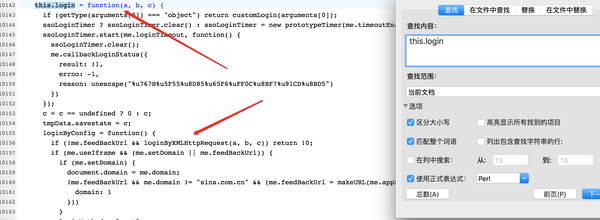

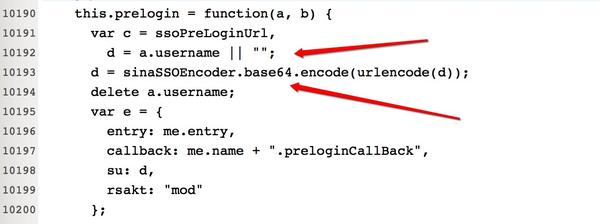

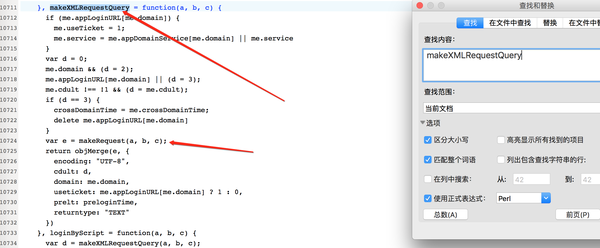

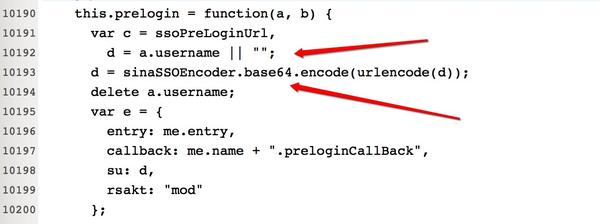

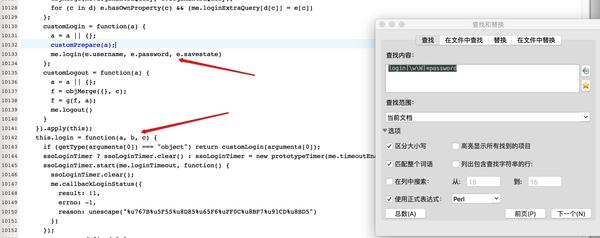

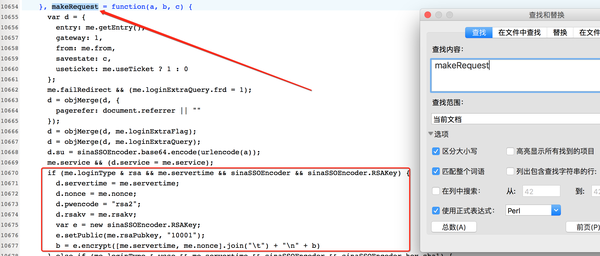

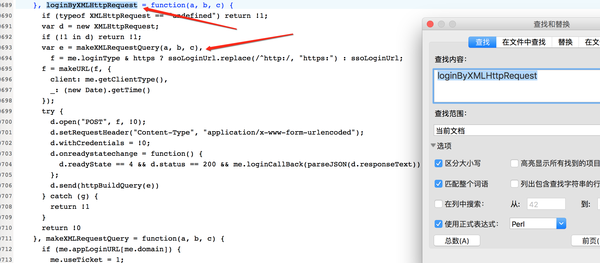

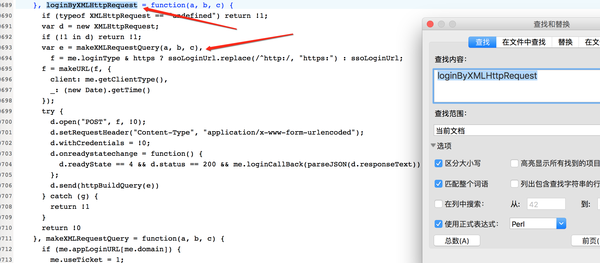

(2)分析的第一步就是要知道如何加密用户名。在Charles中搜索“username”。为什么要这样搜索?如果做网站,估计90%的用户都会给name这个变量命名为username!搜索后发现只有loginLayers.js这个文件收录username,这个文件的命名也说明跟这个文件有关,凭经验应该可以判断这个文件很重要。

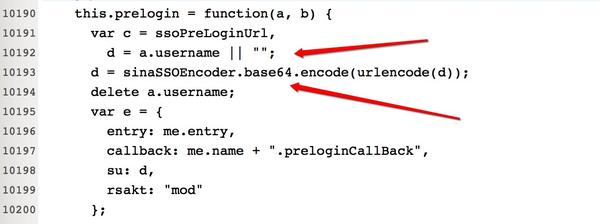

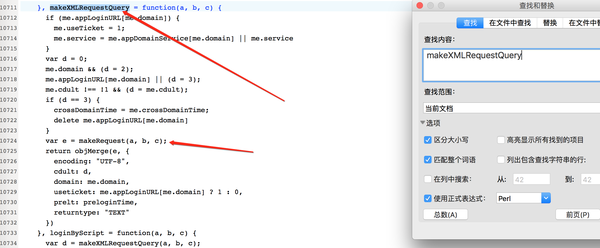

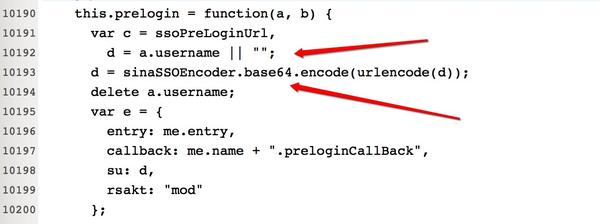

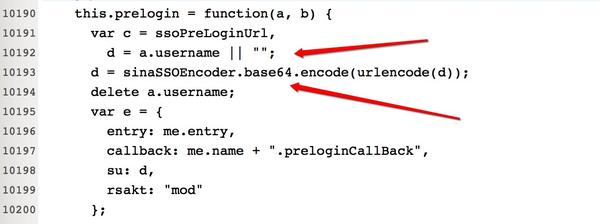

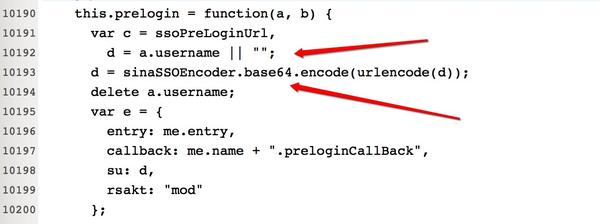

(3)复制这个文件的内容,放到一个文本文件中,搜索username,你会发现下图中这几行代码,然后就知道用户名的加密方法了。user name加密方法很简单,encode后跟一个base64就可以了。具体怎么写Python,自己看代码。

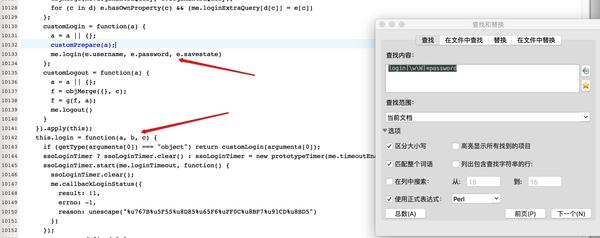

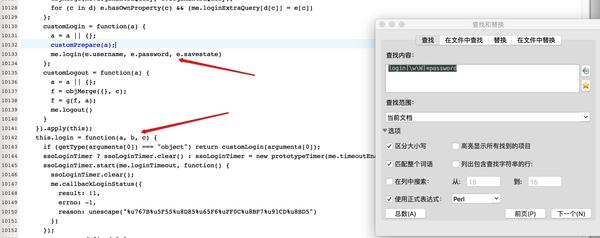

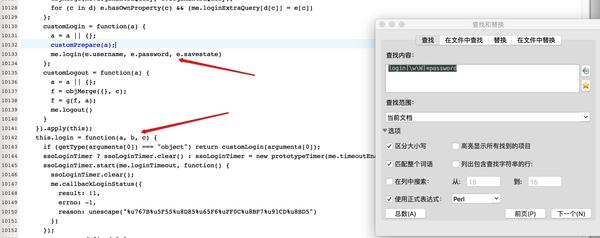

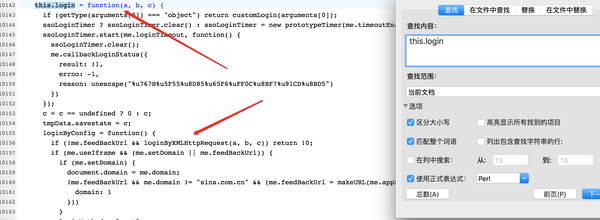

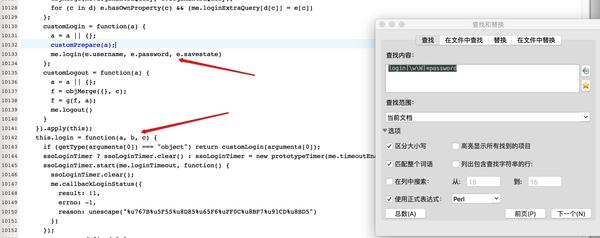

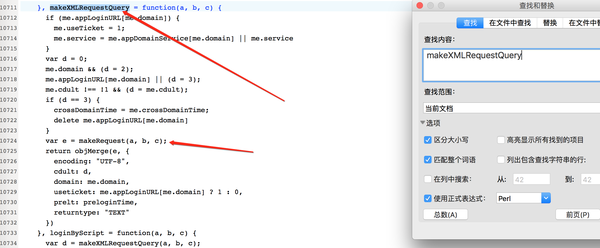

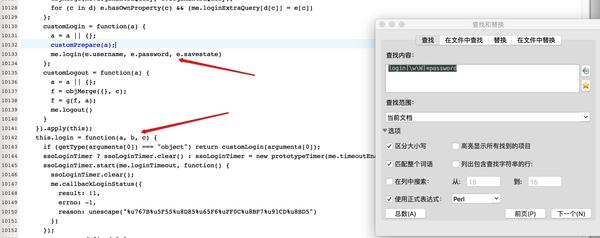

(4)用户名是加密的,密码应该是加密的。继续在这个文件中搜索密码,得到:

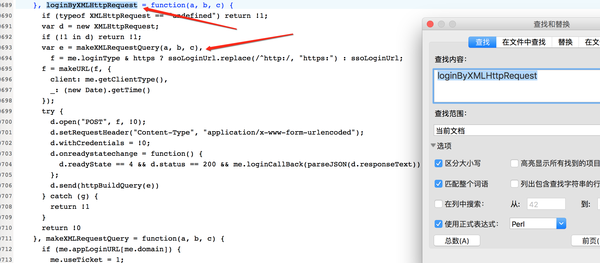

可以推断,this.login中的参数b应该是password。查看登录功能,可以得到:

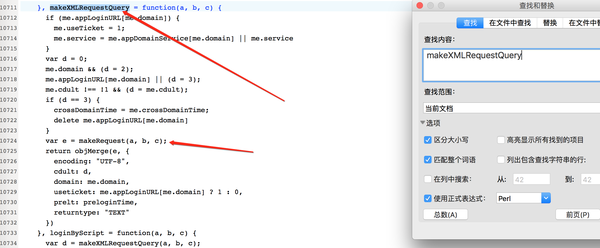

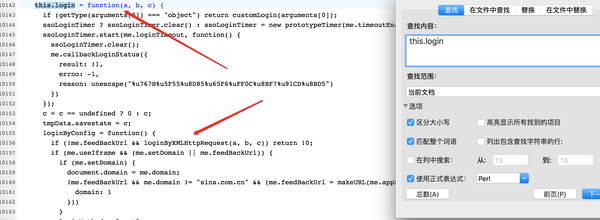

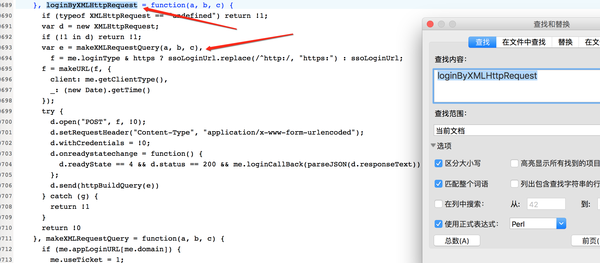

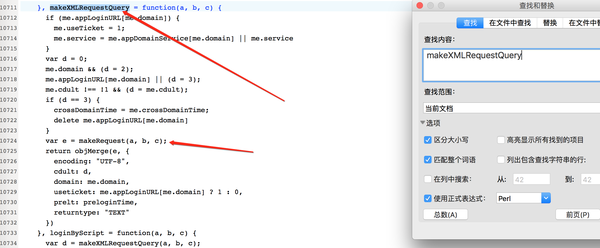

这里调用loginByXMLHttpRequest函数,传入参数b,即password,于是我们继续搜索loginByXMLHttpRequest,得到:

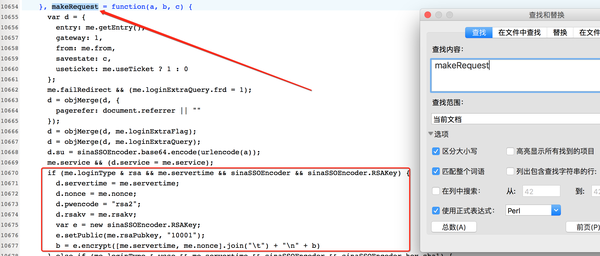

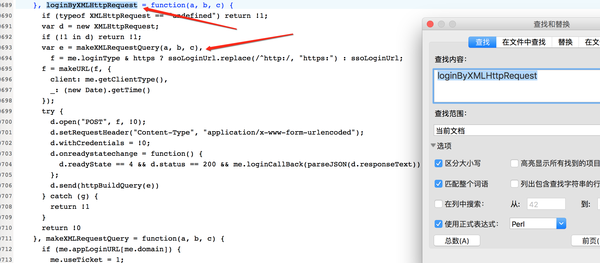

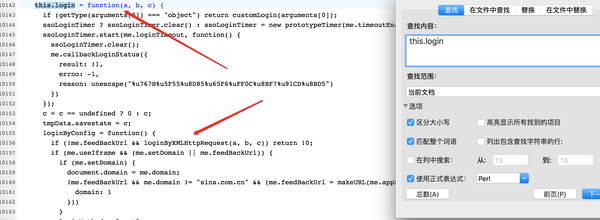

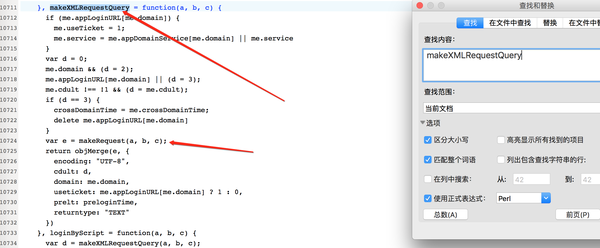

这里调用了makeXMLRequestQuery函数,传入了参数b,即password,于是我们继续搜索makeXMLRequestQuery,得到:

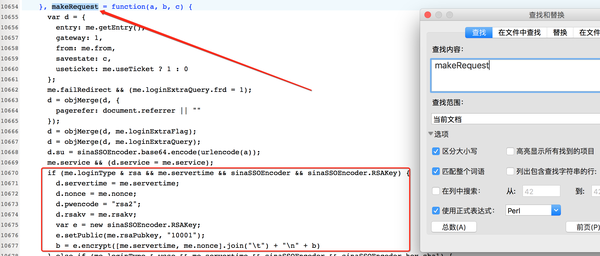

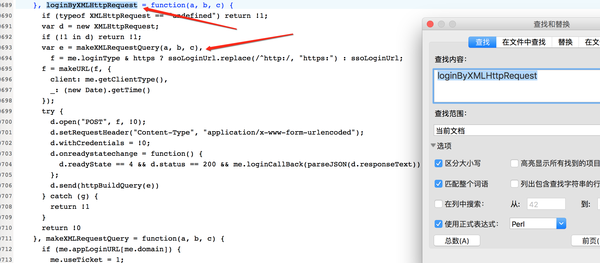

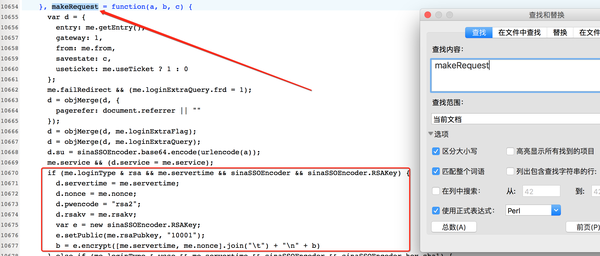

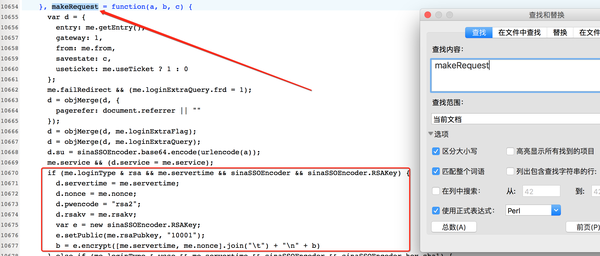

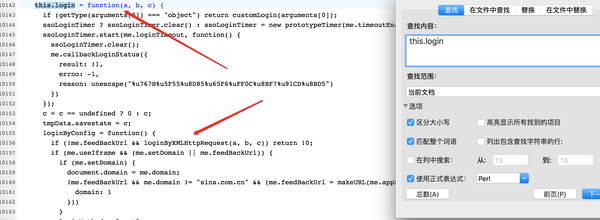

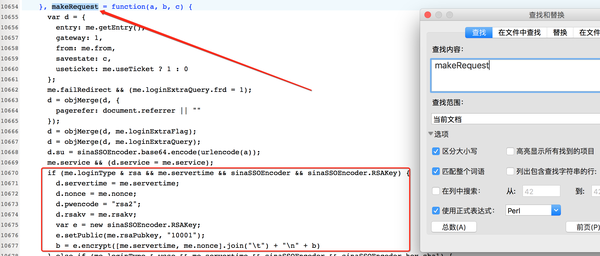

这里调用makeRequest函数,传入参数b,即password,于是我们继续搜索makeRequest,得到:

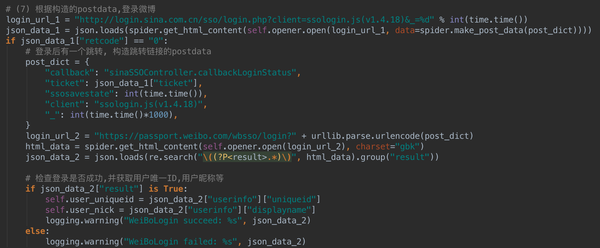

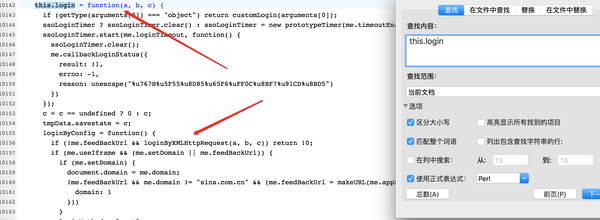

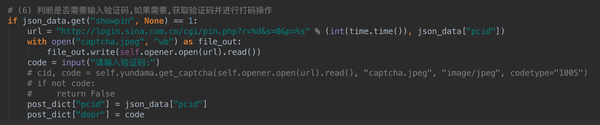

在这里可以清晰的看到密码加密的过程。具体如何实现Python,还是自己看代码。但是这里有一个问题。密码加密的时候,有几个参数需要传入,比如nonce,servertime,rsakv等等,这是什么鬼?继续往下看。

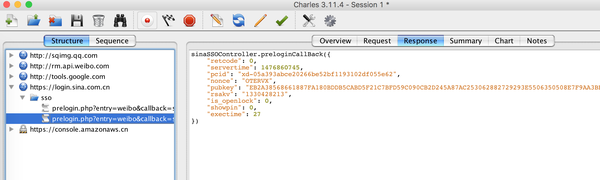

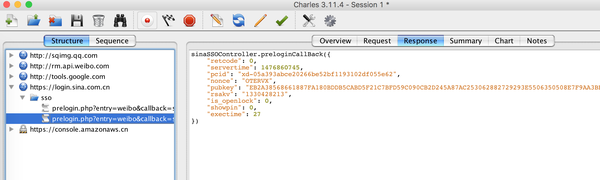

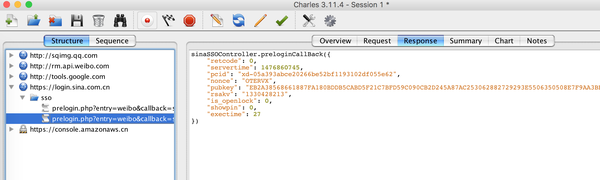

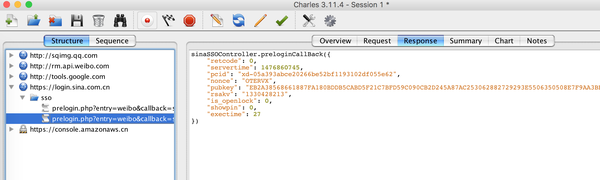

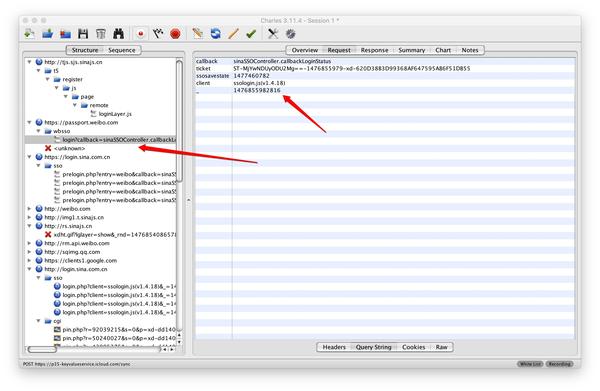

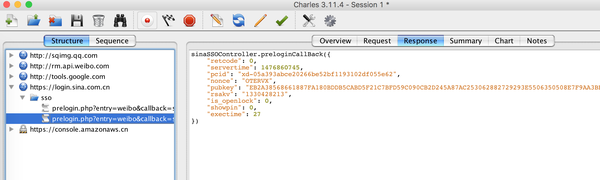

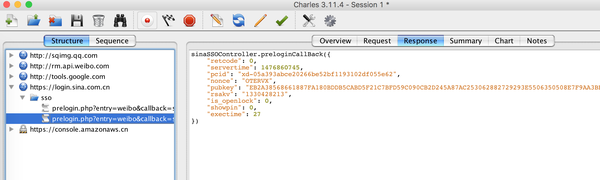

(5)在Charles中搜索servertime,会得到一个prelogin请求,返回servertime,nonce,pubkey等参数,这里返回的是一个json字符串。

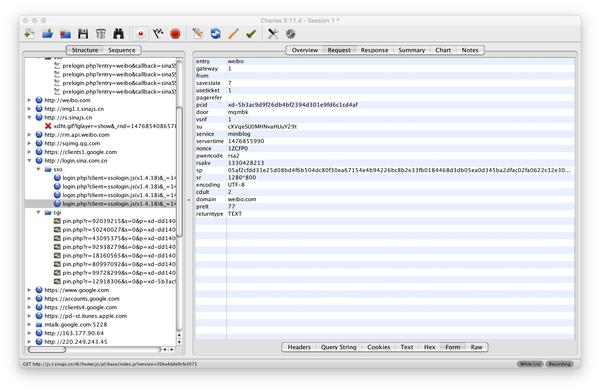

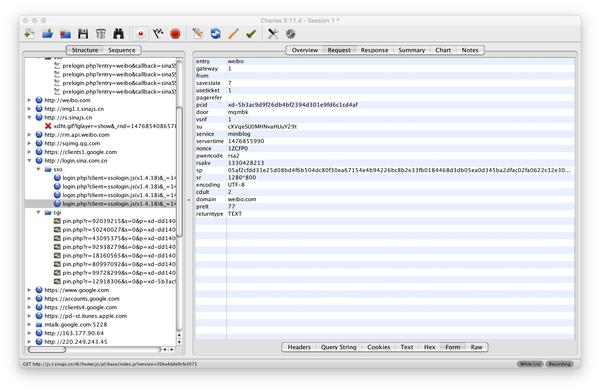

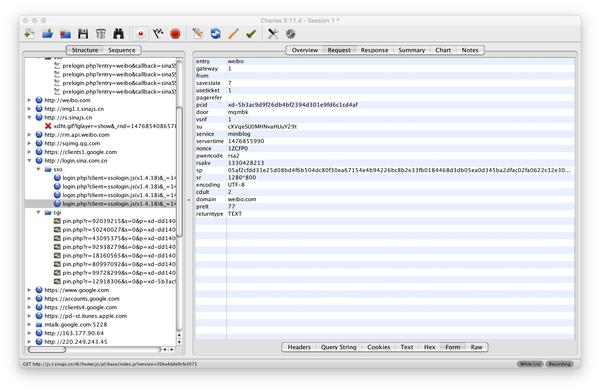

查看请求的请求,可以看到他需要对用户名su进行加密。根据这里的参数,可以对密码进行加密。下面稍微回忆一下,总结一下整个过程:

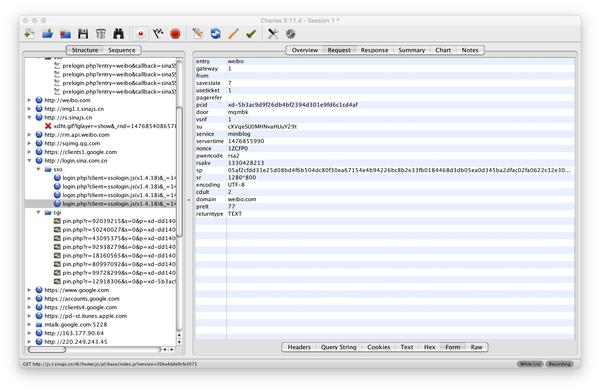

(6)在Charles中可以找到login.php请求,根据经验,可以大致判断这是一个登录请求,结果确实如此,根据请求的请求,您可以自己构建postdata并发送请求。

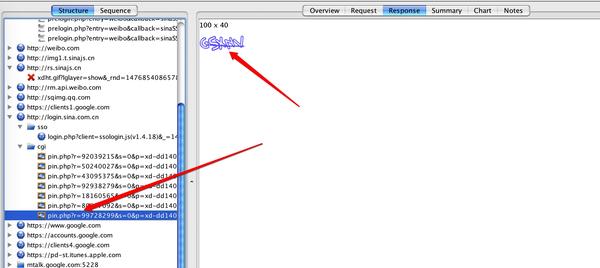

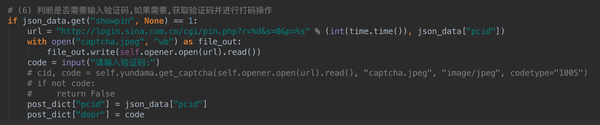

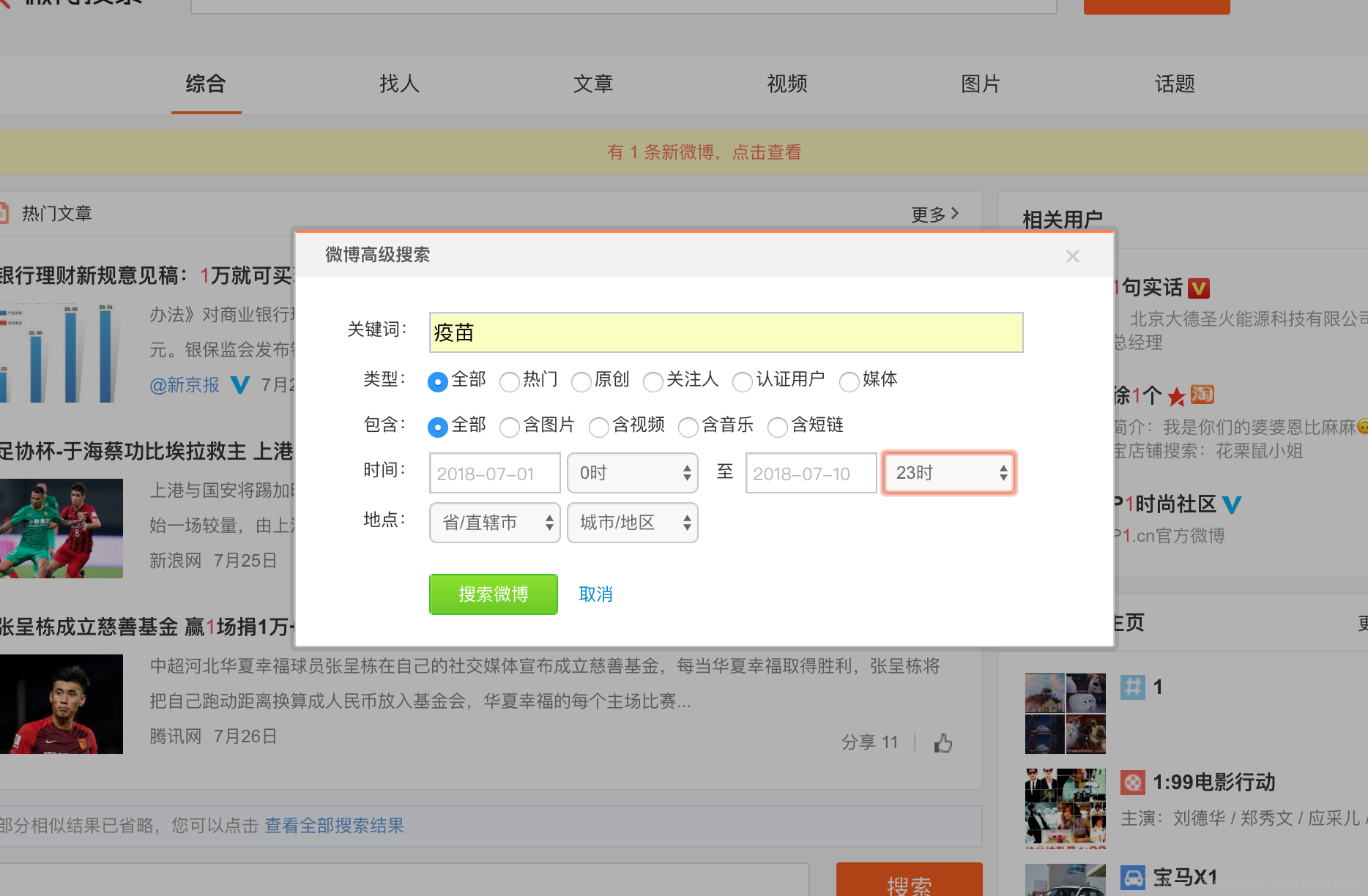

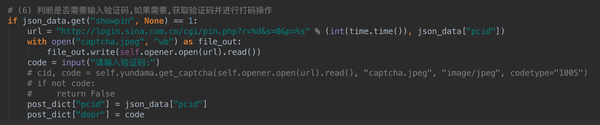

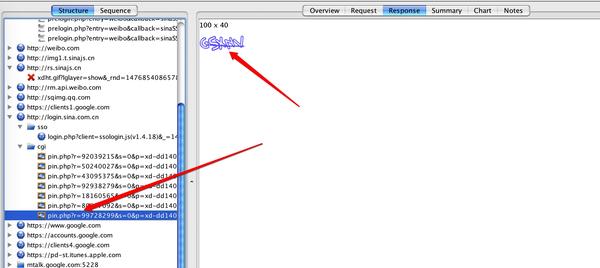

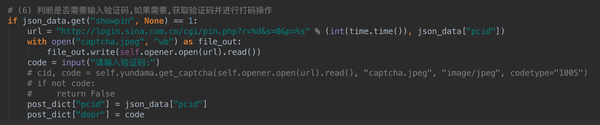

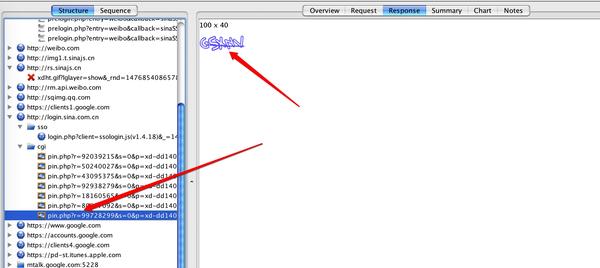

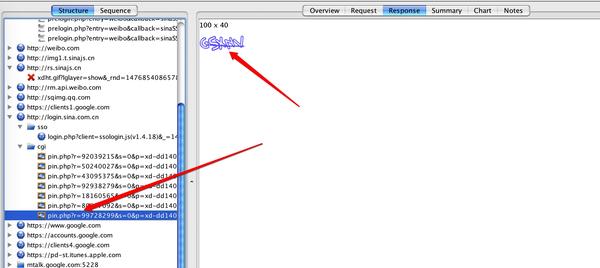

这里需要说明一下验证码问题。有些帐户需要验证码才能登录,有些则不需要。这个跟账号设置有关,有登录保护的需要输入验证码。也可以从上面得到的json字符串中的showpin参数得知(详见上图)。如果需要验证码,只需要找到验证码地址,获取图片即可:

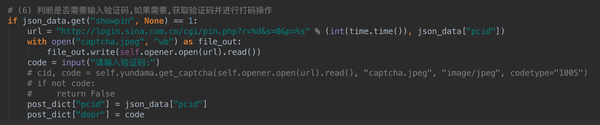

将此图片保存到本地进行手动编码,或访问编码平台,即可获取验证码内容。在我的代码中,本来是封装了云编码平台的接口,直接调用就可以了,但是为了大家测试的方便,我改成了手工编码的形式。详情见代码:

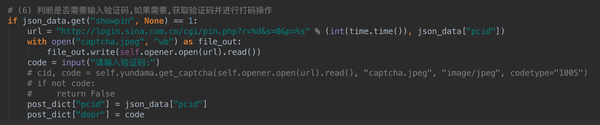

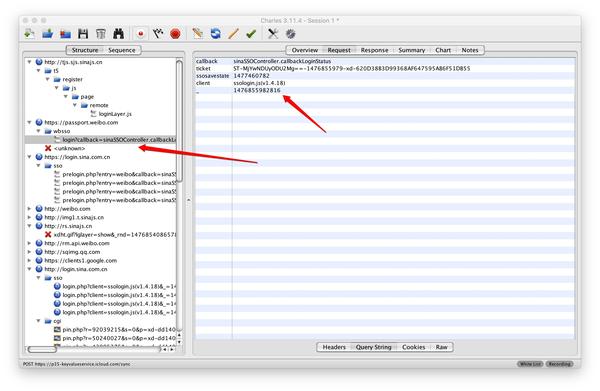

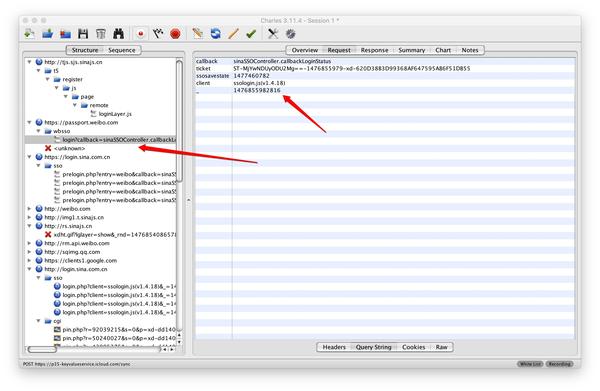

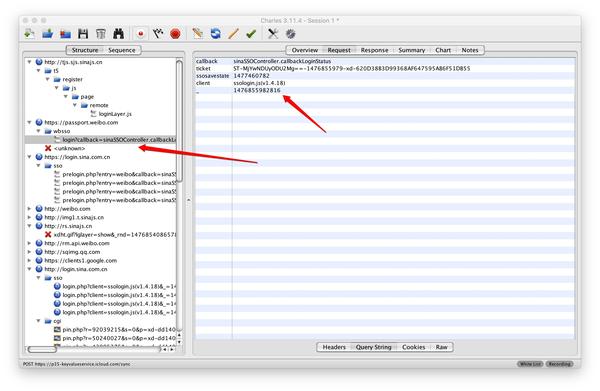

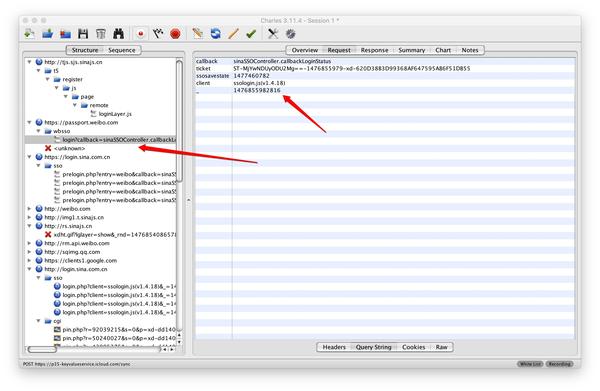

(7) 构造postdata,发送请求,即使请求成功,也登录不成功。因为新浪微博还有一步跳转,麻烦吗?别急,胜利就在眼前我们仔细检查Charles后,会发现在上一个请求之后,还有下一个请求wbsso.login,这是跳转,如下图所示。

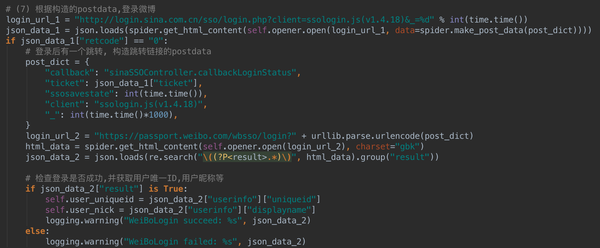

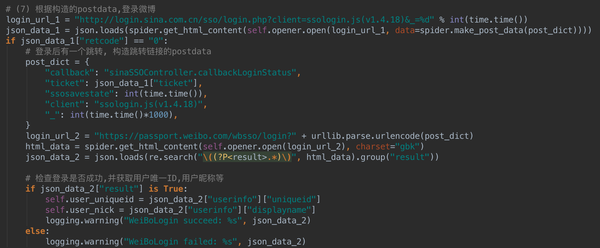

跳转请求的请求是怎么构造的,看代码就可以了,这里就不讲了。代码显示如下:

代码还会检查是否登录成功,这里就不多说了。至此,新浪微博已成功登录。

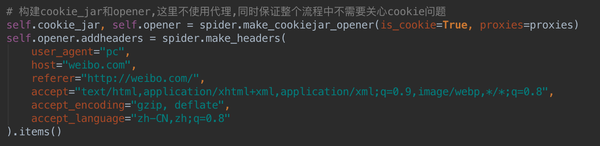

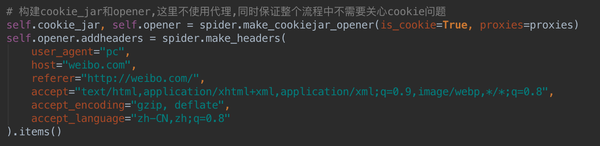

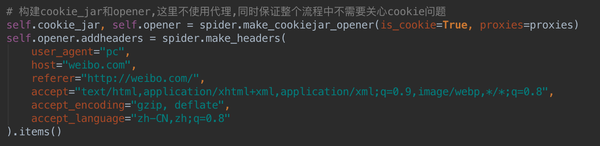

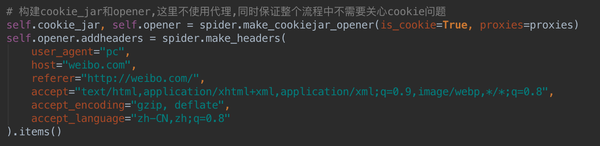

还有一个问题这里没有提到,就是cookie问题。Cookie 在本文中没有提及,因为 Python 中的 Cookiejar 会帮助我们自动处理所有 cookie 问题。您只需要在模拟登录前声明一个 cookiejar 和 opener。这两个东西的具体用法请自行百度。代码显示如下:

微博的模拟登录真的很麻烦,确实需要一定的经验。每个人都练习了很多,并掌握了这一点。相信在模拟登录其他网站的时候,也可以类比破解登录过程。有什么问题可以在评论里指出,有时间我会帮你解答的。

总代码如下:

# _*_ coding: utf-8 _*_

import re

import rsa

import time

import json

import base64

import logging

import binascii

import requests

import urllib.parse

class WeiBoLogin(object):

"""

class of WeiBoLogin, to login weibo.com

"""

def __init__(self):

"""

constructor

"""

self.user_name = None

self.pass_word = None

self.user_uniqueid = None

self.user_nick = None

self.session = requests.Session()

self.session.headers.update({"User-Agent": "Mozilla/5.0 (Windows NT 6.3; WOW64; rv:41.0) Gecko/20100101 Firefox/41.0"})

self.session.get("http://weibo.com/login.php")

return

def login(self, user_name, pass_word):

"""

login weibo.com, return True or False

"""

self.user_name = user_name

self.pass_word = pass_word

self.user_uniqueid = None

self.user_nick = None

# get json data

s_user_name = self.get_username()

json_data = self.get_json_data(su_value=s_user_name)

if not json_data:

return False

s_pass_word = self.get_password(json_data["servertime"], json_data["nonce"], json_data["pubkey"])

# make post_data

post_data = {

"entry": "weibo",

"gateway": "1",

"from": "",

"savestate": "7",

"userticket": "1",

"vsnf": "1",

"service": "miniblog",

"encoding": "UTF-8",

"pwencode": "rsa2",

"sr": "1280*800",

"prelt": "529",

"url": "http://weibo.com/ajaxlogin.php ... ot%3B,

"rsakv": json_data["rsakv"],

"servertime": json_data["servertime"],

"nonce": json_data["nonce"],

"su": s_user_name,

"sp": s_pass_word,

"returntype": "TEXT",

}

# get captcha code

if json_data["showpin"] == 1:

url = "http://login.sina.com.cn/cgi/p ... ot%3B % (int(time.time()), json_data["pcid"])

with open("captcha.jpeg", "wb") as file_out:

file_out.write(self.session.get(url).content)

code = input("请输入验证码:")

post_data["pcid"] = json_data["pcid"]

post_data["door"] = code

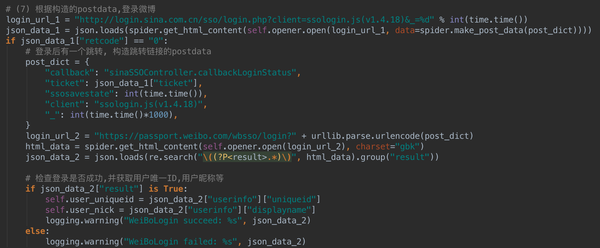

# login weibo.com

login_url_1 = "http://login.sina.com.cn/sso/l ... in.js(v1.4.18)&_=%d" % int(time.time())

json_data_1 = self.session.post(login_url_1, data=post_data).json()

if json_data_1["retcode"] == "0":

params = {

"callback": "sinaSSOController.callbackLoginStatus",

"client": "ssologin.js(v1.4.18)",

"ticket": json_data_1["ticket"],

"ssosavestate": int(time.time()),

"_": int(time.time()*1000),

}

response = self.session.get("https://passport.weibo.com/wbsso/login", params=params)

json_data_2 = json.loads(re.search(r"\((?P.*)\)", response.text).group("result"))

if json_data_2["result"] is True:

self.user_uniqueid = json_data_2["userinfo"]["uniqueid"]

self.user_nick = json_data_2["userinfo"]["displayname"]

logging.warning("WeiBoLogin succeed: %s", json_data_2)

else:

logging.warning("WeiBoLogin failed: %s", json_data_2)

else:

logging.warning("WeiBoLogin failed: %s", json_data_1)

return True if self.user_uniqueid and self.user_nick else False

def get_username(self):

"""

get legal username

"""

username_quote = urllib.parse.quote_plus(self.user_name)

username_base64 = base64.b64encode(username_quote.encode("utf-8"))

return username_base64.decode("utf-8")

def get_json_data(self, su_value):

"""

get the value of "servertime", "nonce", "pubkey", "rsakv" and "showpin", etc

"""

params = {

"entry": "weibo",

"callback": "sinaSSOController.preloginCallBack",

"rsakt": "mod",

"checkpin": "1",

"client": "ssologin.js(v1.4.18)",

"su": su_value,

"_": int(time.time()*1000),

}

try:

response = self.session.get("http://login.sina.com.cn/sso/prelogin.php", params=params)

json_data = json.loads(re.search(r"\((?P.*)\)", response.text).group("data"))

except Exception as excep:

json_data = {}

logging.error("WeiBoLogin get_json_data error: %s", excep)

logging.debug("WeiBoLogin get_json_data: %s", json_data)

return json_data

def get_password(self, servertime, nonce, pubkey):

"""

get legal password

"""

string = (str(servertime) + "\t" + str(nonce) + "\n" + str(self.pass_word)).encode("utf-8")

public_key = rsa.PublicKey(int(pubkey, 16), int("10001", 16))

password = rsa.encrypt(string, public_key)

password = binascii.b2a_hex(password)

return password.decode()

if __name__ == "__main__":

logging.basicConfig(level=logging.DEBUG, format="%(asctime)s\t%(levelname)s\t%(message)s")

weibo = WeiBoLogin()

weibo.login("username", "password")

================================================== ============

作者主页:小虎(Python爱好者,关注爬虫、数据分析、数据挖掘、数据可视化等)

作者专栏首页:代码,学习知识-知乎专栏

作者GitHub主页:代码,学习知识-GitHub

欢迎大家发表评论和评论。相互交流,共同进步!

================================================== ============ 查看全部

网站调用新浪微博内容(如果你想用Python模拟登陆新浪微博,这篇文章绝对你!)

更新:上一版本使用了自用框架PSpider的部分功能。更新后的版本只使用requests库,改写成Class的形式,方便大家运行调试。

-------------------------------------------------- -------------------------------------------------- ----

干货来了,想学Python模拟登录,想知道如何使用抓包工具一步步搞定网站登录流程,想破解网站@ > 登录加密算法,那么这篇文章文章绝对值得你!

标题随意开头,不喜欢,但是这个文章真的很详细的分析了新浪微博的登录过程,包括各种加密算法分析、验证码分析、跳转分析等等。还有登录代码供参考。代码在文章末尾给出,同时上传到GitHub。你可以参考一下。

登录代码地址:GitHub-xianhu/LearnPython:以代码的形式学习Python。

代码中用到了爬虫框架PSpider中的一些功能。看框架:一个非常简洁的Python爬虫框架。

如果你需要学习爬虫的基础知识,请移步:一个很“水”的Python爬虫入门代码文件。

如果想用Python模拟登录新浪微博,首先得去百度了解一些相关知识,了解前人做过一些工作。通过这里搜索,可以知道新浪微博在登录时对用户名和密码进行了加密,也知道了加密算法(b64encode、rsa等)。这是一个总体印象。我会一步一步告诉你如何发现新浪微博的加密算法。毕竟教人钓鱼不如教人钓鱼!

这里用到的工具是Charles,Mac下的抓包工具。Windows 下对应的是 Fiddler。如果您不知道如何使用它或不熟悉它,建议先安装一个并熟悉该软件的使用。

好了,准备工作完成,废话不多说,开始干货!

(1)打开Charles后,打开新浪微博的登录页面,输入用户名、密码和验证码,再次登录。此时Charles将把整个登录过程留给后面分析。

(2)分析的第一步就是要知道如何加密用户名。在Charles中搜索“username”。为什么要这样搜索?如果做网站,估计90%的用户都会给name这个变量命名为username!搜索后发现只有loginLayers.js这个文件收录username,这个文件的命名也说明跟这个文件有关,凭经验应该可以判断这个文件很重要。

(3)复制这个文件的内容,放到一个文本文件中,搜索username,你会发现下图中这几行代码,然后就知道用户名的加密方法了。user name加密方法很简单,encode后跟一个base64就可以了。具体怎么写Python,自己看代码。

(4)用户名是加密的,密码应该是加密的。继续在这个文件中搜索密码,得到:

可以推断,this.login中的参数b应该是password。查看登录功能,可以得到:

这里调用loginByXMLHttpRequest函数,传入参数b,即password,于是我们继续搜索loginByXMLHttpRequest,得到:

这里调用了makeXMLRequestQuery函数,传入了参数b,即password,于是我们继续搜索makeXMLRequestQuery,得到:

这里调用makeRequest函数,传入参数b,即password,于是我们继续搜索makeRequest,得到:

在这里可以清晰的看到密码加密的过程。具体如何实现Python,还是自己看代码。但是这里有一个问题。密码加密的时候,有几个参数需要传入,比如nonce,servertime,rsakv等等,这是什么鬼?继续往下看。

(5)在Charles中搜索servertime,会得到一个prelogin请求,返回servertime,nonce,pubkey等参数,这里返回的是一个json字符串。

查看请求的请求,可以看到他需要对用户名su进行加密。根据这里的参数,可以对密码进行加密。下面稍微回忆一下,总结一下整个过程:

(6)在Charles中可以找到login.php请求,根据经验,可以大致判断这是一个登录请求,结果确实如此,根据请求的请求,您可以自己构建postdata并发送请求。

这里需要说明一下验证码问题。有些帐户需要验证码才能登录,有些则不需要。这个跟账号设置有关,有登录保护的需要输入验证码。也可以从上面得到的json字符串中的showpin参数得知(详见上图)。如果需要验证码,只需要找到验证码地址,获取图片即可:

将此图片保存到本地进行手动编码,或访问编码平台,即可获取验证码内容。在我的代码中,本来是封装了云编码平台的接口,直接调用就可以了,但是为了大家测试的方便,我改成了手工编码的形式。详情见代码:

(7) 构造postdata,发送请求,即使请求成功,也登录不成功。因为新浪微博还有一步跳转,麻烦吗?别急,胜利就在眼前我们仔细检查Charles后,会发现在上一个请求之后,还有下一个请求wbsso.login,这是跳转,如下图所示。

跳转请求的请求是怎么构造的,看代码就可以了,这里就不讲了。代码显示如下:

代码还会检查是否登录成功,这里就不多说了。至此,新浪微博已成功登录。

还有一个问题这里没有提到,就是cookie问题。Cookie 在本文中没有提及,因为 Python 中的 Cookiejar 会帮助我们自动处理所有 cookie 问题。您只需要在模拟登录前声明一个 cookiejar 和 opener。这两个东西的具体用法请自行百度。代码显示如下:

微博的模拟登录真的很麻烦,确实需要一定的经验。每个人都练习了很多,并掌握了这一点。相信在模拟登录其他网站的时候,也可以类比破解登录过程。有什么问题可以在评论里指出,有时间我会帮你解答的。

总代码如下:

# _*_ coding: utf-8 _*_

import re

import rsa

import time

import json

import base64

import logging

import binascii

import requests

import urllib.parse

class WeiBoLogin(object):

"""

class of WeiBoLogin, to login weibo.com

"""

def __init__(self):

"""

constructor

"""

self.user_name = None

self.pass_word = None

self.user_uniqueid = None

self.user_nick = None

self.session = requests.Session()

self.session.headers.update({"User-Agent": "Mozilla/5.0 (Windows NT 6.3; WOW64; rv:41.0) Gecko/20100101 Firefox/41.0"})

self.session.get("http://weibo.com/login.php";)

return

def login(self, user_name, pass_word):

"""

login weibo.com, return True or False

"""

self.user_name = user_name

self.pass_word = pass_word

self.user_uniqueid = None

self.user_nick = None

# get json data

s_user_name = self.get_username()

json_data = self.get_json_data(su_value=s_user_name)

if not json_data:

return False

s_pass_word = self.get_password(json_data["servertime"], json_data["nonce"], json_data["pubkey"])

# make post_data

post_data = {

"entry": "weibo",

"gateway": "1",

"from": "",

"savestate": "7",

"userticket": "1",

"vsnf": "1",

"service": "miniblog",

"encoding": "UTF-8",

"pwencode": "rsa2",

"sr": "1280*800",

"prelt": "529",

"url": "http://weibo.com/ajaxlogin.php ... ot%3B,

"rsakv": json_data["rsakv"],

"servertime": json_data["servertime"],

"nonce": json_data["nonce"],

"su": s_user_name,

"sp": s_pass_word,

"returntype": "TEXT",

}

# get captcha code

if json_data["showpin"] == 1:

url = "http://login.sina.com.cn/cgi/p ... ot%3B % (int(time.time()), json_data["pcid"])

with open("captcha.jpeg", "wb") as file_out:

file_out.write(self.session.get(url).content)

code = input("请输入验证码:")

post_data["pcid"] = json_data["pcid"]

post_data["door"] = code

# login weibo.com

login_url_1 = "http://login.sina.com.cn/sso/l ... in.js(v1.4.18)&_=%d" % int(time.time())

json_data_1 = self.session.post(login_url_1, data=post_data).json()

if json_data_1["retcode"] == "0":

params = {

"callback": "sinaSSOController.callbackLoginStatus",

"client": "ssologin.js(v1.4.18)",

"ticket": json_data_1["ticket"],

"ssosavestate": int(time.time()),

"_": int(time.time()*1000),

}

response = self.session.get("https://passport.weibo.com/wbsso/login", params=params)

json_data_2 = json.loads(re.search(r"\((?P.*)\)", response.text).group("result"))

if json_data_2["result"] is True:

self.user_uniqueid = json_data_2["userinfo"]["uniqueid"]

self.user_nick = json_data_2["userinfo"]["displayname"]

logging.warning("WeiBoLogin succeed: %s", json_data_2)

else:

logging.warning("WeiBoLogin failed: %s", json_data_2)

else:

logging.warning("WeiBoLogin failed: %s", json_data_1)

return True if self.user_uniqueid and self.user_nick else False

def get_username(self):

"""

get legal username

"""

username_quote = urllib.parse.quote_plus(self.user_name)

username_base64 = base64.b64encode(username_quote.encode("utf-8"))

return username_base64.decode("utf-8")

def get_json_data(self, su_value):

"""

get the value of "servertime", "nonce", "pubkey", "rsakv" and "showpin", etc

"""

params = {

"entry": "weibo",

"callback": "sinaSSOController.preloginCallBack",

"rsakt": "mod",

"checkpin": "1",

"client": "ssologin.js(v1.4.18)",

"su": su_value,

"_": int(time.time()*1000),

}

try:

response = self.session.get("http://login.sina.com.cn/sso/prelogin.php", params=params)

json_data = json.loads(re.search(r"\((?P.*)\)", response.text).group("data"))

except Exception as excep:

json_data = {}

logging.error("WeiBoLogin get_json_data error: %s", excep)

logging.debug("WeiBoLogin get_json_data: %s", json_data)

return json_data

def get_password(self, servertime, nonce, pubkey):

"""

get legal password

"""

string = (str(servertime) + "\t" + str(nonce) + "\n" + str(self.pass_word)).encode("utf-8")

public_key = rsa.PublicKey(int(pubkey, 16), int("10001", 16))

password = rsa.encrypt(string, public_key)

password = binascii.b2a_hex(password)

return password.decode()

if __name__ == "__main__":

logging.basicConfig(level=logging.DEBUG, format="%(asctime)s\t%(levelname)s\t%(message)s")

weibo = WeiBoLogin()

weibo.login("username", "password")

================================================== ============

作者主页:小虎(Python爱好者,关注爬虫、数据分析、数据挖掘、数据可视化等)

作者专栏首页:代码,学习知识-知乎专栏

作者GitHub主页:代码,学习知识-GitHub

欢迎大家发表评论和评论。相互交流,共同进步!

================================================== ============

网站调用新浪微博内容(如果你想用Python模拟登陆新浪微博,这篇文章绝对你!)

网站优化 • 优采云 发表了文章 • 0 个评论 • 140 次浏览 • 2021-10-27 21:00

更新:上一版本使用了自用框架PSpider的部分功能。更新后的版本只使用requests库,改写成Class的形式,方便大家运行调试。

-------------------------------------------------- -------------------------------------------------- ----

干货来了,想学Python模拟登录,想知道如何使用抓包工具一步步搞定网站登录流程,想破解网站@ > 登录加密算法,那么这篇文章文章绝对值得你!

标题随意开头,不喜欢,但是这个文章真的很详细的分析了新浪微博的登录过程,包括各种加密算法分析、验证码分析、跳转分析等等。还有登录代码供参考。代码在文章末尾给出,同时上传到GitHub。你可以参考一下。

登录代码地址:GitHub-xianhu/LearnPython:以代码的形式学习Python。

代码中用到了爬虫框架PSpider中的一些功能。看框架:一个非常简洁的Python爬虫框架。

如果你需要学习爬虫的基础知识,请移步:一个很“水”的Python爬虫入门代码文件。

如果想用Python模拟登录新浪微博,首先得去百度了解一些相关知识,了解前人做过一些工作。通过这里搜索,可以知道新浪微博在登录时对用户名和密码进行了加密,也知道了加密算法(b64encode、rsa等)。这是一个总体印象。我会一步一步告诉你如何发现新浪微博的加密算法。毕竟教人钓鱼不如教人钓鱼!

这里用到的工具是Charles,Mac下的抓包工具。Windows 下对应的是 Fiddler。如果您不知道如何使用它或不熟悉它,建议先安装一个并熟悉该软件的使用。

好了,准备工作完成,废话不多说,开始干货!

(1)打开Charles后,打开新浪微博的登录页面,输入用户名、密码和验证码,再次登录。此时Charles将把整个登录过程留给后面分析。

(2)分析的第一步就是要知道如何加密用户名。在Charles中搜索“username”。为什么要这样搜索?如果做网站,估计90%的用户都会给name这个变量命名为username!搜索后发现只有loginLayers.js这个文件收录username,这个文件的命名也说明跟这个文件有关,凭经验应该可以判断这个文件很重要。

(3)复制这个文件的内容,放到一个文本文件中,搜索username,你会发现下图中这几行代码,然后就知道用户名的加密方法了。user name加密方法很简单,encode后跟一个base64就可以了。具体怎么写Python,自己看代码。

(4)用户名是加密的,密码应该是加密的。继续在这个文件中搜索密码,得到:

可以推断,this.login中的参数b应该是password。查看登录功能,可以得到:

这里调用loginByXMLHttpRequest函数,传入参数b,即password,于是我们继续搜索loginByXMLHttpRequest,得到:

这里调用了makeXMLRequestQuery函数,传入了参数b,即password,于是我们继续搜索makeXMLRequestQuery,得到:

这里调用makeRequest函数,传入参数b,即password,于是我们继续搜索makeRequest,得到:

在这里可以清晰的看到密码加密的过程。具体如何实现Python,还是自己看代码。但是这里有一个问题。密码加密的时候,有几个参数需要传入,比如nonce,servertime,rsakv等等,这是什么鬼?继续往下看。

(5)在Charles中搜索servertime,会得到一个prelogin请求,返回servertime,nonce,pubkey等参数,这里返回的是一个json字符串。

查看请求的请求,可以看到他需要对用户名su进行加密。根据这里的参数,可以对密码进行加密。下面稍微回忆一下,总结一下整个过程:

(6)在Charles中可以找到login.php请求,根据经验,可以大致判断这是一个登录请求,结果确实如此,根据请求的请求,您可以自己构建postdata并发送请求。

这里需要说明一下验证码问题。有些帐户需要验证码才能登录,有些则不需要。这个跟账号设置有关,有登录保护的需要输入验证码。也可以从上面得到的json字符串中的showpin参数得知(详见上图)。如果需要验证码,只需要找到验证码地址,获取图片即可:

将此图片保存到本地进行手动编码,或访问编码平台,即可获取验证码内容。在我的代码中,本来是封装了云编码平台的接口,直接调用就可以了,但是为了大家测试的方便,我改成了手工编码的形式。详情见代码:

(7) 构造postdata,发送请求,即使请求成功,也登录不成功。因为新浪微博还有一步跳转,麻烦吗?别急,胜利就在眼前我们仔细检查Charles后,会发现在上一个请求之后,还有下一个请求wbsso.login,这是跳转,如下图所示。

跳转请求的请求是怎么构造的,看代码就可以了,这里就不讲了。代码显示如下:

代码还会检查是否登录成功,这里就不多说了。至此,新浪微博已成功登录。

还有一个问题这里没有提到,就是cookie问题。Cookie 在本文中没有提及,因为 Python 中的 Cookiejar 会帮助我们自动处理所有 cookie 问题。您只需要在模拟登录前声明一个 cookiejar 和 opener。这两个东西的具体用法请自行百度。代码显示如下:

微博的模拟登录真的很麻烦,确实需要一定的经验。每个人都练习了很多,并掌握了这一点。相信在模拟登录其他网站的时候,也可以类比破解登录过程。有什么问题可以在评论里指出,有时间我会帮你解答的。

总代码如下:

# _*_ coding: utf-8 _*_

import re

import rsa

import time

import json

import base64

import logging

import binascii

import requests

import urllib.parse

class WeiBoLogin(object):

"""

class of WeiBoLogin, to login weibo.com

"""

def __init__(self):

"""

constructor

"""

self.user_name = None

self.pass_word = None

self.user_uniqueid = None

self.user_nick = None

self.session = requests.Session()

self.session.headers.update({"User-Agent": "Mozilla/5.0 (Windows NT 6.3; WOW64; rv:41.0) Gecko/20100101 Firefox/41.0"})

self.session.get("http://weibo.com/login.php")

return

def login(self, user_name, pass_word):

"""

login weibo.com, return True or False

"""

self.user_name = user_name

self.pass_word = pass_word

self.user_uniqueid = None

self.user_nick = None

# get json data

s_user_name = self.get_username()

json_data = self.get_json_data(su_value=s_user_name)

if not json_data:

return False

s_pass_word = self.get_password(json_data["servertime"], json_data["nonce"], json_data["pubkey"])

# make post_data

post_data = {

"entry": "weibo",

"gateway": "1",

"from": "",

"savestate": "7",

"userticket": "1",

"vsnf": "1",

"service": "miniblog",

"encoding": "UTF-8",

"pwencode": "rsa2",

"sr": "1280*800",

"prelt": "529",

"url": "http://weibo.com/ajaxlogin.php ... ot%3B,

"rsakv": json_data["rsakv"],

"servertime": json_data["servertime"],

"nonce": json_data["nonce"],

"su": s_user_name,

"sp": s_pass_word,

"returntype": "TEXT",

}

# get captcha code

if json_data["showpin"] == 1:

url = "http://login.sina.com.cn/cgi/p ... ot%3B % (int(time.time()), json_data["pcid"])

with open("captcha.jpeg", "wb") as file_out:

file_out.write(self.session.get(url).content)

code = input("请输入验证码:")

post_data["pcid"] = json_data["pcid"]

post_data["door"] = code

# login weibo.com

login_url_1 = "http://login.sina.com.cn/sso/l ... in.js(v1.4.18)&_=%d" % int(time.time())

json_data_1 = self.session.post(login_url_1, data=post_data).json()

if json_data_1["retcode"] == "0":

params = {

"callback": "sinaSSOController.callbackLoginStatus",

"client": "ssologin.js(v1.4.18)",

"ticket": json_data_1["ticket"],

"ssosavestate": int(time.time()),

"_": int(time.time()*1000),

}

response = self.session.get("https://passport.weibo.com/wbsso/login", params=params)

json_data_2 = json.loads(re.search(r"\((?P.*)\)", response.text).group("result"))

if json_data_2["result"] is True:

self.user_uniqueid = json_data_2["userinfo"]["uniqueid"]

self.user_nick = json_data_2["userinfo"]["displayname"]

logging.warning("WeiBoLogin succeed: %s", json_data_2)

else:

logging.warning("WeiBoLogin failed: %s", json_data_2)

else:

logging.warning("WeiBoLogin failed: %s", json_data_1)

return True if self.user_uniqueid and self.user_nick else False

def get_username(self):

"""

get legal username

"""

username_quote = urllib.parse.quote_plus(self.user_name)

username_base64 = base64.b64encode(username_quote.encode("utf-8"))

return username_base64.decode("utf-8")

def get_json_data(self, su_value):

"""

get the value of "servertime", "nonce", "pubkey", "rsakv" and "showpin", etc

"""

params = {

"entry": "weibo",

"callback": "sinaSSOController.preloginCallBack",

"rsakt": "mod",

"checkpin": "1",

"client": "ssologin.js(v1.4.18)",

"su": su_value,

"_": int(time.time()*1000),

}

try:

response = self.session.get("http://login.sina.com.cn/sso/prelogin.php", params=params)

json_data = json.loads(re.search(r"\((?P.*)\)", response.text).group("data"))

except Exception as excep:

json_data = {}

logging.error("WeiBoLogin get_json_data error: %s", excep)

logging.debug("WeiBoLogin get_json_data: %s", json_data)

return json_data

def get_password(self, servertime, nonce, pubkey):

"""

get legal password

"""

string = (str(servertime) + "\t" + str(nonce) + "\n" + str(self.pass_word)).encode("utf-8")

public_key = rsa.PublicKey(int(pubkey, 16), int("10001", 16))

password = rsa.encrypt(string, public_key)

password = binascii.b2a_hex(password)

return password.decode()

if __name__ == "__main__":

logging.basicConfig(level=logging.DEBUG, format="%(asctime)s\t%(levelname)s\t%(message)s")

weibo = WeiBoLogin()

weibo.login("username", "password")

================================================== ============

作者主页:小虎(Python爱好者,关注爬虫、数据分析、数据挖掘、数据可视化等)

作者专栏首页:代码,学习知识-知乎专栏

作者GitHub主页:代码,学习知识-GitHub

欢迎大家发表评论和评论。相互交流,共同进步!

================================================== ============ 查看全部

网站调用新浪微博内容(如果你想用Python模拟登陆新浪微博,这篇文章绝对你!)

更新:上一版本使用了自用框架PSpider的部分功能。更新后的版本只使用requests库,改写成Class的形式,方便大家运行调试。

-------------------------------------------------- -------------------------------------------------- ----

干货来了,想学Python模拟登录,想知道如何使用抓包工具一步步搞定网站登录流程,想破解网站@ > 登录加密算法,那么这篇文章文章绝对值得你!

标题随意开头,不喜欢,但是这个文章真的很详细的分析了新浪微博的登录过程,包括各种加密算法分析、验证码分析、跳转分析等等。还有登录代码供参考。代码在文章末尾给出,同时上传到GitHub。你可以参考一下。

登录代码地址:GitHub-xianhu/LearnPython:以代码的形式学习Python。

代码中用到了爬虫框架PSpider中的一些功能。看框架:一个非常简洁的Python爬虫框架。

如果你需要学习爬虫的基础知识,请移步:一个很“水”的Python爬虫入门代码文件。

如果想用Python模拟登录新浪微博,首先得去百度了解一些相关知识,了解前人做过一些工作。通过这里搜索,可以知道新浪微博在登录时对用户名和密码进行了加密,也知道了加密算法(b64encode、rsa等)。这是一个总体印象。我会一步一步告诉你如何发现新浪微博的加密算法。毕竟教人钓鱼不如教人钓鱼!