网站自动采集文章

网站自动采集文章( SEO优化的好帮手——Dedecmsdedecms采集规则、采集)

采集交流 • 优采云 发表了文章 • 0 个评论 • 159 次浏览 • 2022-01-16 19:23

SEO优化的好帮手——Dedecmsdedecms采集规则、采集)

Dedecms采集,集成织梦dede发布接口,提供Dedecms自动采集,Dedecms自动更新,< @织梦自动发布、织梦dede网站SEO等强大功能,让站长轻松采集发布到织梦。优化的好帮手。 织梦dedecms采集系统真不错,省去你手动添加信息的麻烦,设置dede采集规则,采集分,然后点击采集,OK,几百个文章就搞定了! dedecms采集程序自动采集为dedecms管理系统的程序推送信息,dedecms采集主要是dedecms管理系统程序自动推送信息,采集主要信息来源为各大新闻源,后续推送程序会逐渐增多,采集@的文章源站> 也会逐渐增加。

Dedecms采集具有以下特点:

1.自动内链,对文中指定的关键词添加自定义链接,控制内链数。 SEO优化工具——自动内链,在文本中指定关键词添加自定义链接,控制内链数。合理的内链可以提升收录和权重。

2.多语言翻译,简繁体转换,翻译支持百度、有道API接口。多语言同声传译,翻译后的内容存储在一个新的字段中;支持简繁体中文转换。支持多语言同声翻译,翻译后的内容存储在新的字段中,翻译后的内容会自动切分并保留图片。

3.正文自动插入其他记录的摘要,并在正文的开头、中间和结尾插入一段。摘要来自其他采集的数据,格式可以自定义,不影响用户阅读。在文本中随机插入动态段落:指在文章文本的开头、中间和结尾处(或仅一个位置)插入摘要,插入段落的内容来自其他< @采集 在同一个任务中。无需预先定义段落,只需定义段落格式。 文章在正文前、中、后插入内容,有利于收录,不影响用户阅读。在正文中插入动态段落对 SEO 非常有用收录!

4.在文本中自动插入自定义段落和标题关键词,在文本的开头、中间和结尾随机插入用户提供的段落,并添加对应的关键词段落的标题最后。在文章正文的开头、中间和结尾处随机插入用户提供的段落,并在标题后缀加上段落对应的关键词。

采集规则不用手写,也不用研究网页源码。集成智能识别引擎自动识别数据和规则,包括:翻页、网页详情(如标题、正文、发布日期、作者、标签等)智能识别提取,效率比传统采集器@提高十倍> 配置!无缝连接10多种cms或接口,配置简单,即可发布数据到各种cms系统,自定义Http接口或数据库;也可以导出为Excel、Sql、CSV。多样化的图片下载和存储方式,配置简单,可以自动下载图片和替换链接,图片存储方式支持:阿里云OSS、七牛对象存储、腾讯云、有拍云等定时采集+定时定量自动发布,设置后可以定时发布采集,轻松实现内容定时定量自动更新。强大的SEO工具,提供自动内链、翻译等辅助工具;自动过滤无用内容和广告等批量操作,保证数据的整齐显示格式。 查看全部

网站自动采集文章(

SEO优化的好帮手——Dedecmsdedecms采集规则、采集)

Dedecms采集,集成织梦dede发布接口,提供Dedecms自动采集,Dedecms自动更新,< @织梦自动发布、织梦dede网站SEO等强大功能,让站长轻松采集发布到织梦。优化的好帮手。 织梦dedecms采集系统真不错,省去你手动添加信息的麻烦,设置dede采集规则,采集分,然后点击采集,OK,几百个文章就搞定了! dedecms采集程序自动采集为dedecms管理系统的程序推送信息,dedecms采集主要是dedecms管理系统程序自动推送信息,采集主要信息来源为各大新闻源,后续推送程序会逐渐增多,采集@的文章源站> 也会逐渐增加。

Dedecms采集具有以下特点:

1.自动内链,对文中指定的关键词添加自定义链接,控制内链数。 SEO优化工具——自动内链,在文本中指定关键词添加自定义链接,控制内链数。合理的内链可以提升收录和权重。

2.多语言翻译,简繁体转换,翻译支持百度、有道API接口。多语言同声传译,翻译后的内容存储在一个新的字段中;支持简繁体中文转换。支持多语言同声翻译,翻译后的内容存储在新的字段中,翻译后的内容会自动切分并保留图片。

3.正文自动插入其他记录的摘要,并在正文的开头、中间和结尾插入一段。摘要来自其他采集的数据,格式可以自定义,不影响用户阅读。在文本中随机插入动态段落:指在文章文本的开头、中间和结尾处(或仅一个位置)插入摘要,插入段落的内容来自其他< @采集 在同一个任务中。无需预先定义段落,只需定义段落格式。 文章在正文前、中、后插入内容,有利于收录,不影响用户阅读。在正文中插入动态段落对 SEO 非常有用收录!

4.在文本中自动插入自定义段落和标题关键词,在文本的开头、中间和结尾随机插入用户提供的段落,并添加对应的关键词段落的标题最后。在文章正文的开头、中间和结尾处随机插入用户提供的段落,并在标题后缀加上段落对应的关键词。

采集规则不用手写,也不用研究网页源码。集成智能识别引擎自动识别数据和规则,包括:翻页、网页详情(如标题、正文、发布日期、作者、标签等)智能识别提取,效率比传统采集器@提高十倍> 配置!无缝连接10多种cms或接口,配置简单,即可发布数据到各种cms系统,自定义Http接口或数据库;也可以导出为Excel、Sql、CSV。多样化的图片下载和存储方式,配置简单,可以自动下载图片和替换链接,图片存储方式支持:阿里云OSS、七牛对象存储、腾讯云、有拍云等定时采集+定时定量自动发布,设置后可以定时发布采集,轻松实现内容定时定量自动更新。强大的SEO工具,提供自动内链、翻译等辅助工具;自动过滤无用内容和广告等批量操作,保证数据的整齐显示格式。

网站自动采集文章(采集最大的优势扩大网站收录收录增加网站排名! )

采集交流 • 优采云 发表了文章 • 0 个评论 • 146 次浏览 • 2022-01-16 10:15

)

dedecms采集器不知道大家有没有听说过,可能很多站长都没接触过采集! 采集最大的好处就是扩大网站收录提升网站的排名,获得更多的流量,相信还是有大部分人采集可以的别过来收录,放弃采集!其实来自采集的文章也需要处理。很多人采集自带的文章源码里面有别人留下的超链接,还有JS广告,更何况采集里面的文章布局错位了。今天博主就教大家使用dedecms采集的进阶篇。适用于任何 cms规则采集。同时还为小白分享了一套更简单的采集方法,无需编写规则,只需2个简单步骤即可完成,直接上手!

一、通过 SEO 软件工具关键词采集:

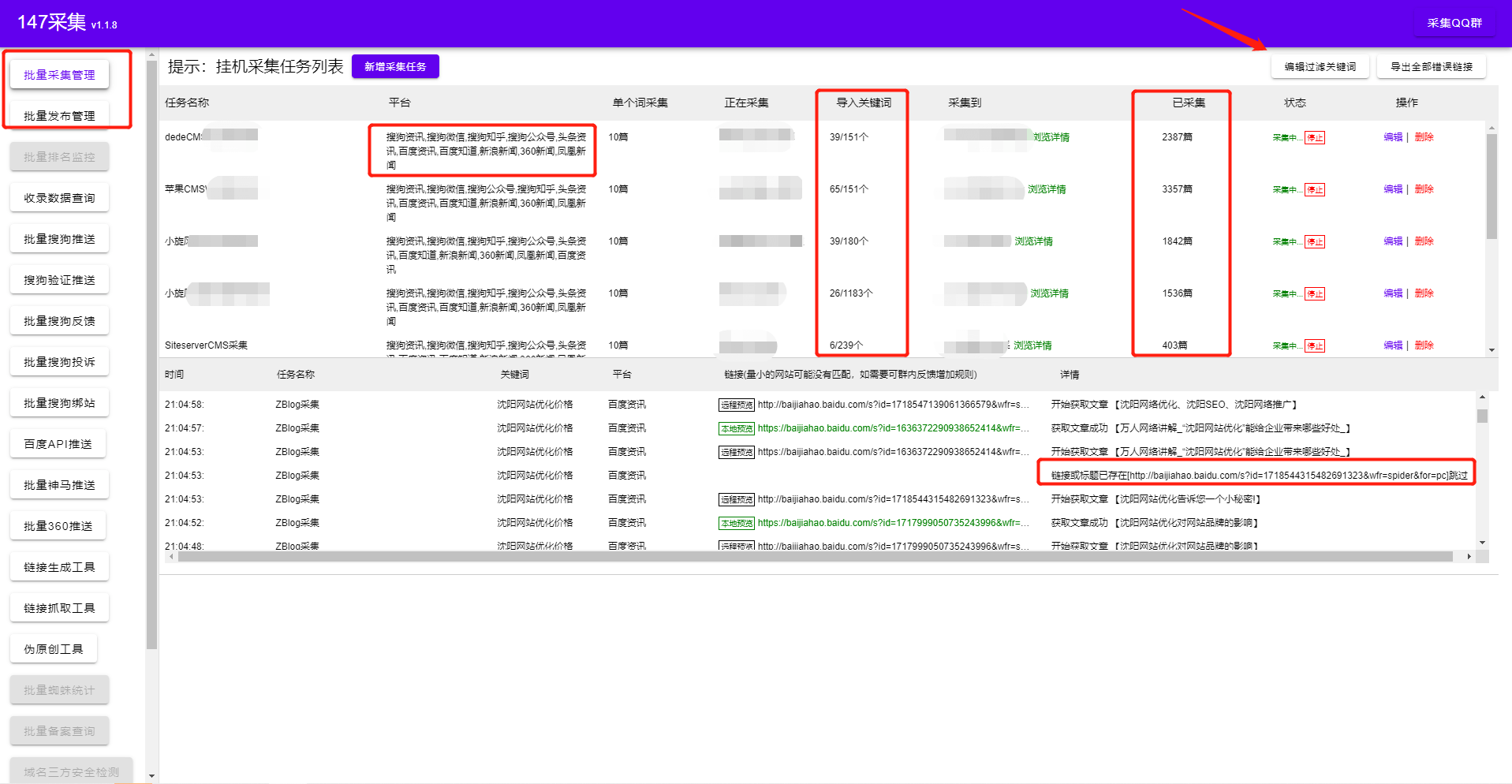

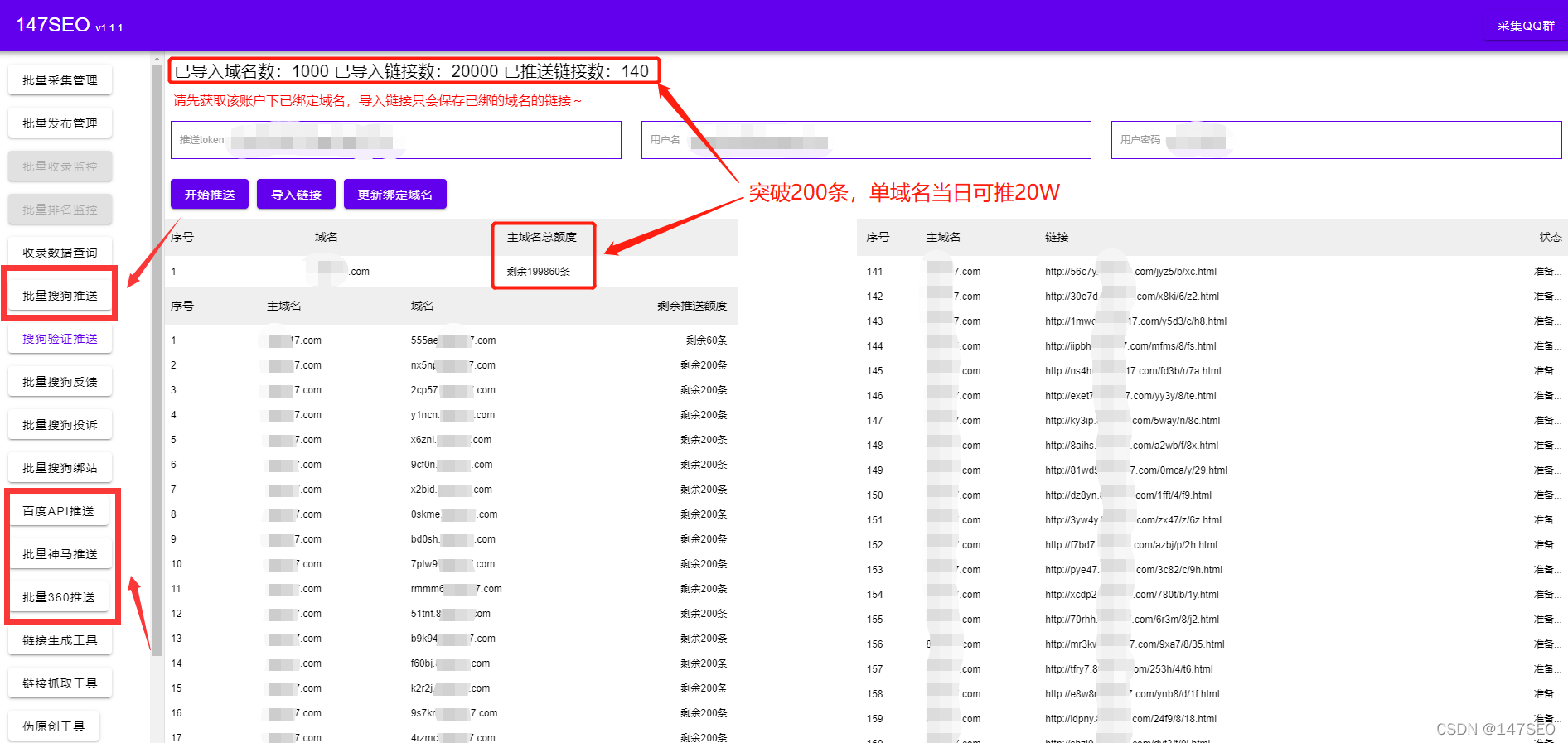

无需学习更多专业技能,只需几个简单的步骤即可轻松采集内容数据,精准发布站点,用户只需对软件进行简单设置,完成后软件将根据用户设置采集 @关键词内容与图片高精度匹配,自动执行文章采集伪原创发布,提供方便快捷的内容填充服务! !

相比自己写规则采集门槛更低。您无需花费大量时间学习正则表达式或 html 标签。您可以在一分钟内开始。只需输入关键词即可实现采集。一路挂断!设置任务自动执行采集发布任务。几十万个不同的cms网站可以统一管理。一个人维护数百个 网站文章 更新也不是问题。

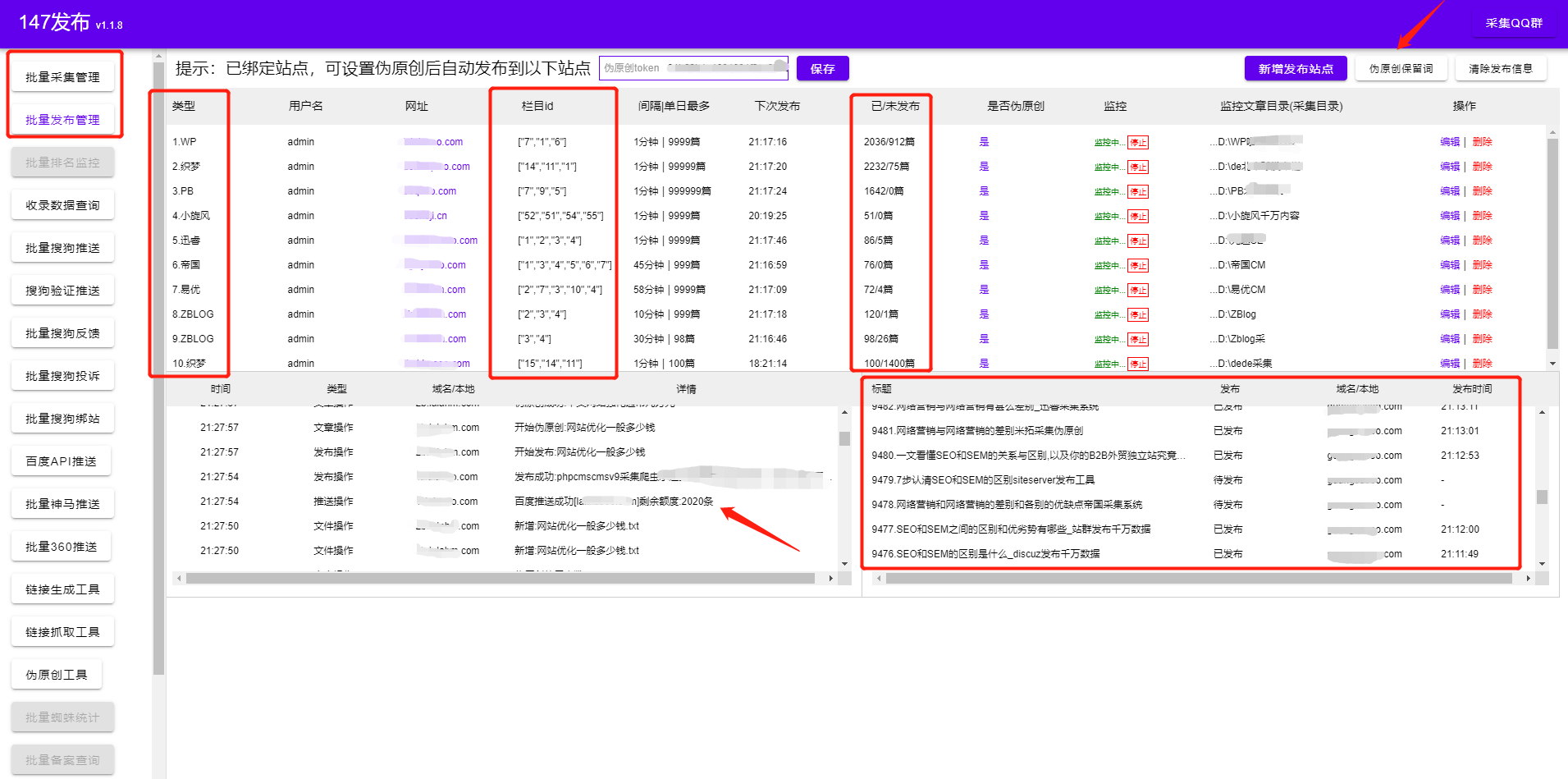

这类工具还是为小白配备了强大的SEO功能,可以通过软件采集自动采集和发布文章,设置自动下载图片并保存本地或第三方。自动内部链接、前后插入内容或标题,以及网站内容插入或随机作者、随机阅读等,形成“伪原创”。通过这些SEO小功能提升网站页面原创度,提升网站收录排名。软件工具上还有监控功能,可以通过软件直接查看文章采集的发布状态。目前博主亲测软件是免费的,可以直接下载使用!

二、dedecms采集规则进阶版适用于所有文章

编写采集规则

1、删除超链接,这是最常见的。 (留下样式里的字,去掉)

]*)>{/dede:trim}

{/dede:修剪}

如果这个被填了,那么链接的文字也会被删除

]*)>(.*){/dede:trim}(删除所有内容)

2、过滤JS调用广告,比如GG广告,加这个:

]*)>(.*){/dede:trim}

3、过滤 div 标签。

这是非常重要的。如果过滤不干净,可能会导致发布的文章布局错位。目前遇到采集后出现错位的原因大部分都在这里。

{/dede:修剪}

{/dede:修剪}

有时也需要这个过滤器:

(.*){/dede:trim}

删除 DIV 和 DIV 内的所有内容:

]*)>(.*){/dede:trim}

4、其他过滤规则可以根据以上规则推导出来。

5、过滤器总结和关键字用法,常用。

{/dede:修剪}

6、简单替换。 (样式内容替换)示例:==>

要替换的单词{/dede:trim}

内容

采集 还需要搜索引擎 收录。过滤和替换的目的是减少重复。对于伪原创,具体操作看个人需求和喜好。

小编现在正在用这个软件制作一个采集站,可以实现所有行业相关的内容采集。 收录现在90万多人,权重低一点,只有4的权重,采集网站也可以,但是需要配合一些SEO技巧。看完这篇文章,如果觉得不错,不妨采集一下,或者发给有需要的朋友和同事!关注博主,每天为你带来不一样的SEO知识。你的一举一动都会成为小编源源不断的动力!

查看全部

网站自动采集文章(采集最大的优势扩大网站收录收录增加网站排名!

)

dedecms采集器不知道大家有没有听说过,可能很多站长都没接触过采集! 采集最大的好处就是扩大网站收录提升网站的排名,获得更多的流量,相信还是有大部分人采集可以的别过来收录,放弃采集!其实来自采集的文章也需要处理。很多人采集自带的文章源码里面有别人留下的超链接,还有JS广告,更何况采集里面的文章布局错位了。今天博主就教大家使用dedecms采集的进阶篇。适用于任何 cms规则采集。同时还为小白分享了一套更简单的采集方法,无需编写规则,只需2个简单步骤即可完成,直接上手!

一、通过 SEO 软件工具关键词采集:

无需学习更多专业技能,只需几个简单的步骤即可轻松采集内容数据,精准发布站点,用户只需对软件进行简单设置,完成后软件将根据用户设置采集 @关键词内容与图片高精度匹配,自动执行文章采集伪原创发布,提供方便快捷的内容填充服务! !

相比自己写规则采集门槛更低。您无需花费大量时间学习正则表达式或 html 标签。您可以在一分钟内开始。只需输入关键词即可实现采集。一路挂断!设置任务自动执行采集发布任务。几十万个不同的cms网站可以统一管理。一个人维护数百个 网站文章 更新也不是问题。

这类工具还是为小白配备了强大的SEO功能,可以通过软件采集自动采集和发布文章,设置自动下载图片并保存本地或第三方。自动内部链接、前后插入内容或标题,以及网站内容插入或随机作者、随机阅读等,形成“伪原创”。通过这些SEO小功能提升网站页面原创度,提升网站收录排名。软件工具上还有监控功能,可以通过软件直接查看文章采集的发布状态。目前博主亲测软件是免费的,可以直接下载使用!

二、dedecms采集规则进阶版适用于所有文章

编写采集规则

1、删除超链接,这是最常见的。 (留下样式里的字,去掉)

]*)>{/dede:trim}

{/dede:修剪}

如果这个被填了,那么链接的文字也会被删除

]*)>(.*){/dede:trim}(删除所有内容)

2、过滤JS调用广告,比如GG广告,加这个:

]*)>(.*){/dede:trim}

3、过滤 div 标签。

这是非常重要的。如果过滤不干净,可能会导致发布的文章布局错位。目前遇到采集后出现错位的原因大部分都在这里。

{/dede:修剪}

{/dede:修剪}

有时也需要这个过滤器:

(.*){/dede:trim}

删除 DIV 和 DIV 内的所有内容:

]*)>(.*){/dede:trim}

4、其他过滤规则可以根据以上规则推导出来。

5、过滤器总结和关键字用法,常用。

{/dede:修剪}

6、简单替换。 (样式内容替换)示例:==>

要替换的单词{/dede:trim}

内容

采集 还需要搜索引擎 收录。过滤和替换的目的是减少重复。对于伪原创,具体操作看个人需求和喜好。

小编现在正在用这个软件制作一个采集站,可以实现所有行业相关的内容采集。 收录现在90万多人,权重低一点,只有4的权重,采集网站也可以,但是需要配合一些SEO技巧。看完这篇文章,如果觉得不错,不妨采集一下,或者发给有需要的朋友和同事!关注博主,每天为你带来不一样的SEO知识。你的一举一动都会成为小编源源不断的动力!

网站自动采集文章( SEO技术分享2022-01-08网站采集工具文章采集器 )

采集交流 • 优采云 发表了文章 • 0 个评论 • 184 次浏览 • 2022-01-15 07:13

SEO技术分享2022-01-08网站采集工具文章采集器

)

网站采集工具是全自动的采集已发布

SEO技术分享2022-01-08

网站采集工具文章采集器不知道各位小伙伴有没有听说过,可能很多SEO同学没接触过吧!网站采集工具都是站群或者大型门户网站和一些企业站点人员使用的,当然还有很多个人站长,为什么要用网站采集@ >工具 对于高级SEO人员来说,一个好的网站采集工具简直就是个辅助神器,不仅可以快速收录还可以快速获得关键词排名流量!

如何选择好的网站采集工具?

1、按 关键词采集文章 而不写 采集 规则。自动全网采集,覆盖六大搜索引擎。自动过滤内容相关度和文章平滑度,只有采集高度相关和平滑度文章。自动映射,智能伪原创,定时采集,自动发布,自动提交到搜索引擎,支持各种cms和站群程序。采集任务每天定时定量完成!您只需要设置必要的参数即可实现高质量的全托管无人值守自动更新文章。

2、简单到关键词 开始采集。无需关心网页源代码,全程鼠标操作即可。操作界面友好直观。全智能辅助。考虑到多功能性和复杂性。可适用于各种特殊场合,满足各种特殊要求。

3、使用的网站采集工具必须支持主要的cms采集发布,可以在短时间内采集大量内容时间的

4、 无需人工考勤,软件更新频繁,功能齐全,软件免费

5、采集速度是采集软件中速度最快的之一。独有的多模板功能+智能纠错模式,保证结果数据100%完整性。

6、根据内容相似度判断文章的可重复性,准确率100%不会采集重复文章

7、通用模拟发布(无需开发针对性发布接口文件,可匹配任意网站cms自动后台发布)

为什么我们需要 采集 工具来做 网站?可以快速丰富网站的内容,减少手动发布内容的繁琐。最重要的是它可以快速轻松地为网站添加大量内容。因为站长希望把别人的网站内容放到自己的网站中,从内容中提取相关字段,发布到自己的网站系统中。站长的日常工作就是提供丰富的网站内容,从而吸引更多的流量。采集系统就像一双慧眼,让你看得更远,收获更多。

首先要知道很多大网站都有自己的专业程序员和SEO人员,很多网站对采集@的行为都做了各种干扰措施>。传统的采集工具都是依靠分析网页源代码,利用正则表达式技术从网页源代码中提取特殊内容。这个工具完全不同,采用仿浏览器解析技术,所以这些抗采集干扰的措施对于这个工具来说基本是无效的。许多公司或网站管理员没有强大的技术支持。您只能通过找到满足您需求的 网站采集 工具来提高您的工作效率。

我只是用上面的软件自动采集最新的优质内容,并配置了多种数据处理选项,标签、链接、邮件等格式处理来制作网站内容独一无二,快速提升自己网站的流量!看完这篇文章,如果觉得不错,不妨采集一下,或者发给有需要的朋友和同事!你的一举一动都会成为小编源源不断的动力!

查看全部

网站自动采集文章(

SEO技术分享2022-01-08网站采集工具文章采集器

)

网站采集工具是全自动的采集已发布

SEO技术分享2022-01-08

网站采集工具文章采集器不知道各位小伙伴有没有听说过,可能很多SEO同学没接触过吧!网站采集工具都是站群或者大型门户网站和一些企业站点人员使用的,当然还有很多个人站长,为什么要用网站采集@ >工具 对于高级SEO人员来说,一个好的网站采集工具简直就是个辅助神器,不仅可以快速收录还可以快速获得关键词排名流量!

如何选择好的网站采集工具?

1、按 关键词采集文章 而不写 采集 规则。自动全网采集,覆盖六大搜索引擎。自动过滤内容相关度和文章平滑度,只有采集高度相关和平滑度文章。自动映射,智能伪原创,定时采集,自动发布,自动提交到搜索引擎,支持各种cms和站群程序。采集任务每天定时定量完成!您只需要设置必要的参数即可实现高质量的全托管无人值守自动更新文章。

2、简单到关键词 开始采集。无需关心网页源代码,全程鼠标操作即可。操作界面友好直观。全智能辅助。考虑到多功能性和复杂性。可适用于各种特殊场合,满足各种特殊要求。

3、使用的网站采集工具必须支持主要的cms采集发布,可以在短时间内采集大量内容时间的

4、 无需人工考勤,软件更新频繁,功能齐全,软件免费

5、采集速度是采集软件中速度最快的之一。独有的多模板功能+智能纠错模式,保证结果数据100%完整性。

6、根据内容相似度判断文章的可重复性,准确率100%不会采集重复文章

7、通用模拟发布(无需开发针对性发布接口文件,可匹配任意网站cms自动后台发布)

为什么我们需要 采集 工具来做 网站?可以快速丰富网站的内容,减少手动发布内容的繁琐。最重要的是它可以快速轻松地为网站添加大量内容。因为站长希望把别人的网站内容放到自己的网站中,从内容中提取相关字段,发布到自己的网站系统中。站长的日常工作就是提供丰富的网站内容,从而吸引更多的流量。采集系统就像一双慧眼,让你看得更远,收获更多。

首先要知道很多大网站都有自己的专业程序员和SEO人员,很多网站对采集@的行为都做了各种干扰措施>。传统的采集工具都是依靠分析网页源代码,利用正则表达式技术从网页源代码中提取特殊内容。这个工具完全不同,采用仿浏览器解析技术,所以这些抗采集干扰的措施对于这个工具来说基本是无效的。许多公司或网站管理员没有强大的技术支持。您只能通过找到满足您需求的 网站采集 工具来提高您的工作效率。

我只是用上面的软件自动采集最新的优质内容,并配置了多种数据处理选项,标签、链接、邮件等格式处理来制作网站内容独一无二,快速提升自己网站的流量!看完这篇文章,如果觉得不错,不妨采集一下,或者发给有需要的朋友和同事!你的一举一动都会成为小编源源不断的动力!

网站自动采集文章( WordPress发布工具无需插件和API,自动批量同时具备SEO优化 )

采集交流 • 优采云 发表了文章 • 0 个评论 • 213 次浏览 • 2022-01-08 06:10

WordPress发布工具无需插件和API,自动批量同时具备SEO优化

)

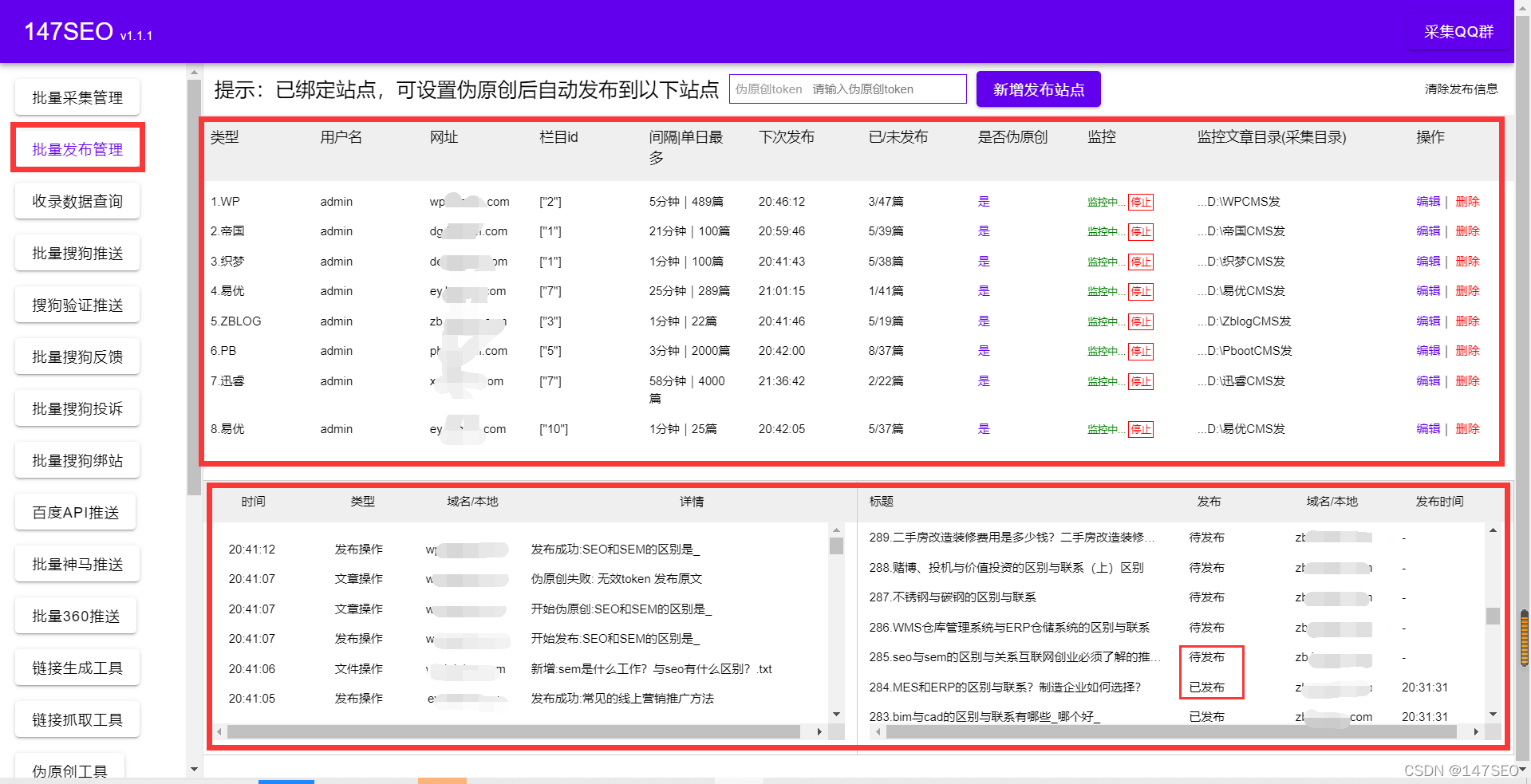

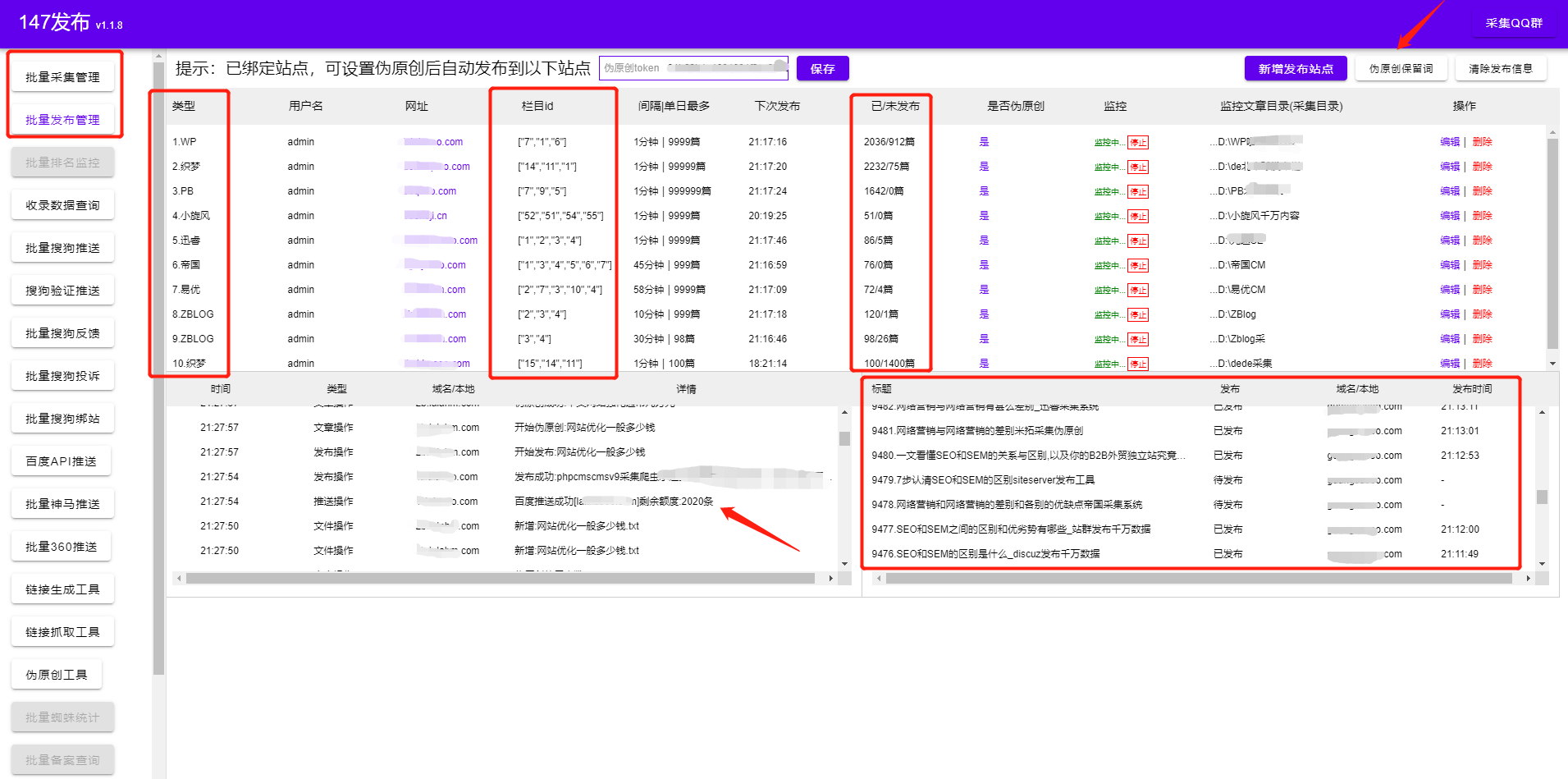

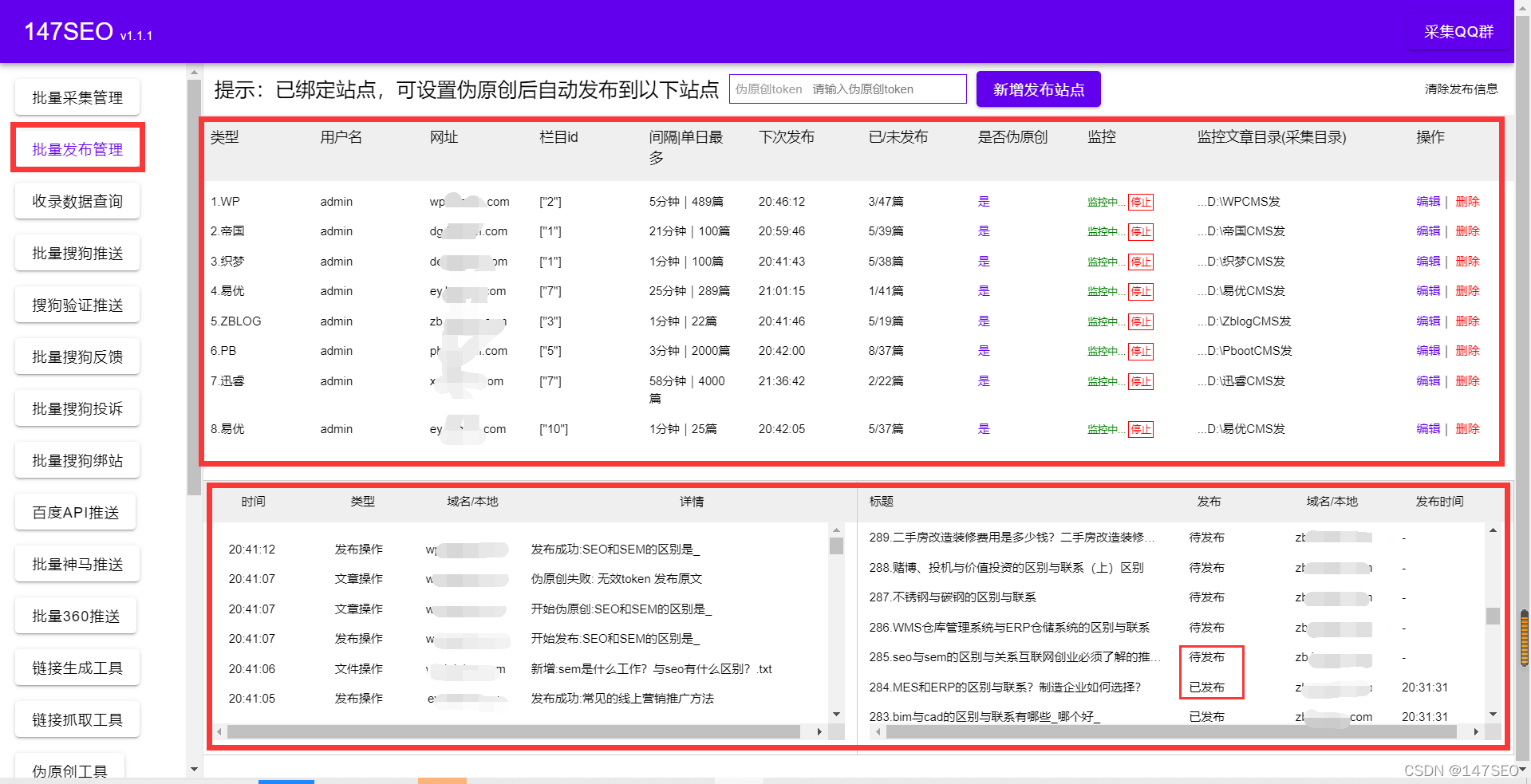

WordPress发布工具,无需插件和API,实现WPcms发布文章,自动批量SEO优化。WordPress发布可以实现网站自动采集和发布,即以量取胜的方式获得百度收录和关键词排名,从而获得被动搜索引擎交通。WordPress发布还配备了采集功能和自动伪原创,可以采集几乎所有类型的网页,无缝适配各类cms建站者,发布数据实时无需登录,实现定时定量自动采集发布,无需人工干预!就是站长网站管理,网站优化,大数据,云时代网站 数据自动化采集发布的SEO优化必备工具。更准确地说,WorePress 发布不仅仅是一个发布工具,它可以实现多个网站multiplecms同时同步管理,通过一个工具管理所有网站。各种网站cms都是我自己做的。利用工具的便利,我做的网站无论是收录还是排名效果都相当不错。

WordPress发布功能这么多,难道就是市场所说的站群软件吗?确实可以理解站群和独立站点都可以管理采集发布SEO优化!WordPress版本的具体功能是什么:

1.一键批量创建任务,无需规则,填写网站基本信息,方便简单,最大化功能,简化操作

2.批量管理各种cms类型的网站,让你所有的网站都能自动批量发布文章,

3.自带伪原创的功能,使得发布的文章更加原创友好,增加了搜索引擎的友好度。收录 网站 的速率增加

4. 规律性和每日发帖数让搜索引擎觉得这是一个正常而有规律的网站,增强信任感

5.发布可以自动删除自动监控,减少负载,无论是本地还是服务器,不占用资源

6.自带关键词内链插入,在标题和文章中自动插入关键词,增加关键词的频率,对于网站< @关键词排名网站体重提升有帮助

7. 发布后自动推送到百度|搜狗|神马|360,主动推送资源,缩短爬虫发现网站链接的时间,增加网站收录

8. 自带点赞数随机、图片随机插入、作者随机生成,让用户体验和直观感受更加真实生动

WordPress无缝发布采集,采集的功能不需要自己写规则,操作也极其简单,直接上手即可,根据情况选择数据源即可网站,批量导入关键词就是这样,如果没有关键词词库,可以输入一个核心关键词生成大量长尾关键词 在线。不管是采集还是发布,都是傻瓜式操作,一看就懂,一用就懂。真正意义上的功能最大化,操作极其简化。是站长网站建设、网站管理、SEO优化的常备工具。大大提高了工作效率,提高优化效果,快速达到预期目标。.

WordPress发布的文章分享就写在这里。综上所述,我们在SEO优化的过程中会遇到很多问题。有技术和效率方面。我们需要分析总结,借助工具来解决繁琐的手工工作,同时对提升网站自然排名优化起到重要作用。

查看全部

网站自动采集文章(

WordPress发布工具无需插件和API,自动批量同时具备SEO优化

)

WordPress发布工具,无需插件和API,实现WPcms发布文章,自动批量SEO优化。WordPress发布可以实现网站自动采集和发布,即以量取胜的方式获得百度收录和关键词排名,从而获得被动搜索引擎交通。WordPress发布还配备了采集功能和自动伪原创,可以采集几乎所有类型的网页,无缝适配各类cms建站者,发布数据实时无需登录,实现定时定量自动采集发布,无需人工干预!就是站长网站管理,网站优化,大数据,云时代网站 数据自动化采集发布的SEO优化必备工具。更准确地说,WorePress 发布不仅仅是一个发布工具,它可以实现多个网站multiplecms同时同步管理,通过一个工具管理所有网站。各种网站cms都是我自己做的。利用工具的便利,我做的网站无论是收录还是排名效果都相当不错。

WordPress发布功能这么多,难道就是市场所说的站群软件吗?确实可以理解站群和独立站点都可以管理采集发布SEO优化!WordPress版本的具体功能是什么:

1.一键批量创建任务,无需规则,填写网站基本信息,方便简单,最大化功能,简化操作

2.批量管理各种cms类型的网站,让你所有的网站都能自动批量发布文章,

3.自带伪原创的功能,使得发布的文章更加原创友好,增加了搜索引擎的友好度。收录 网站 的速率增加

4. 规律性和每日发帖数让搜索引擎觉得这是一个正常而有规律的网站,增强信任感

5.发布可以自动删除自动监控,减少负载,无论是本地还是服务器,不占用资源

6.自带关键词内链插入,在标题和文章中自动插入关键词,增加关键词的频率,对于网站< @关键词排名网站体重提升有帮助

7. 发布后自动推送到百度|搜狗|神马|360,主动推送资源,缩短爬虫发现网站链接的时间,增加网站收录

8. 自带点赞数随机、图片随机插入、作者随机生成,让用户体验和直观感受更加真实生动

WordPress无缝发布采集,采集的功能不需要自己写规则,操作也极其简单,直接上手即可,根据情况选择数据源即可网站,批量导入关键词就是这样,如果没有关键词词库,可以输入一个核心关键词生成大量长尾关键词 在线。不管是采集还是发布,都是傻瓜式操作,一看就懂,一用就懂。真正意义上的功能最大化,操作极其简化。是站长网站建设、网站管理、SEO优化的常备工具。大大提高了工作效率,提高优化效果,快速达到预期目标。.

WordPress发布的文章分享就写在这里。综上所述,我们在SEO优化的过程中会遇到很多问题。有技术和效率方面。我们需要分析总结,借助工具来解决繁琐的手工工作,同时对提升网站自然排名优化起到重要作用。

网站自动采集文章(清爽娱乐网源码亲测.69优化文章未设置发布日期时自动获取)

采集交流 • 优采云 发表了文章 • 0 个评论 • 179 次浏览 • 2022-01-04 01:16

本站所有源代码均可构建亲测!只提供源码学习参考!如需安装配置请联系网站客服索取报价!

源代码介绍和安装说明:

青双娱乐网络系统可应用于网站图、文、视频、音频的构建。它承载的数据量大,访问量大,安全性高。功能和模板可以通过插件进行扩展。

1、自动化程度高:自动设置文章第一张图为缩略图。自动检测第一张图像。第一个安装环境自动填充页面空缺。电脑版自动生成导航栏二级下拉菜单,自动采集文章,自动发布文章,自动生成静态(高级功能),自动定时发布(高级功能) )、自动搜索引擎推送(高级功能) 自动本地保存图片(高级功能) 自动过滤危险提交(高级功能) 会员自动充值(高级功能)

2、一键替换功能和模板高级功能插件带来丰富扩展,后台一键安装模板可随意切换替换,后台一键安装

3、支持微信小程序、APP、百度MIP、微信小程序、APP、百度MIP、微信小程序、APP、百度MIP、微信、后台管理(高级功能)

4、搜索引擎友好 整个站点具有静态、动态和伪静态功能。具有主动提交、自动提交、搜索引擎生成站点地图(高级功能)。全站写入标准html标签,有利于SEO,全站可生成全局内链关键词

源码更新日志:

刷新娱乐网源码v5.69

优化文章未设置发布日期时自动获取当前时间的逻辑

萌猫资源网测试截图:

-----本页内容结束,喜欢请分享! ----- 查看全部

网站自动采集文章(清爽娱乐网源码亲测.69优化文章未设置发布日期时自动获取)

本站所有源代码均可构建亲测!只提供源码学习参考!如需安装配置请联系网站客服索取报价!

源代码介绍和安装说明:

青双娱乐网络系统可应用于网站图、文、视频、音频的构建。它承载的数据量大,访问量大,安全性高。功能和模板可以通过插件进行扩展。

1、自动化程度高:自动设置文章第一张图为缩略图。自动检测第一张图像。第一个安装环境自动填充页面空缺。电脑版自动生成导航栏二级下拉菜单,自动采集文章,自动发布文章,自动生成静态(高级功能),自动定时发布(高级功能) )、自动搜索引擎推送(高级功能) 自动本地保存图片(高级功能) 自动过滤危险提交(高级功能) 会员自动充值(高级功能)

2、一键替换功能和模板高级功能插件带来丰富扩展,后台一键安装模板可随意切换替换,后台一键安装

3、支持微信小程序、APP、百度MIP、微信小程序、APP、百度MIP、微信小程序、APP、百度MIP、微信、后台管理(高级功能)

4、搜索引擎友好 整个站点具有静态、动态和伪静态功能。具有主动提交、自动提交、搜索引擎生成站点地图(高级功能)。全站写入标准html标签,有利于SEO,全站可生成全局内链关键词

源码更新日志:

刷新娱乐网源码v5.69

优化文章未设置发布日期时自动获取当前时间的逻辑

萌猫资源网测试截图:

https://mm.mmwp.net/wp-content ... 0.jpg 118w, https://mm.mmwp.net/wp-content ... 4.jpg 402w, https://mm.mmwp.net/wp-content ... 6.jpg 604w" />

https://mm.mmwp.net/wp-content ... 0.jpg 118w, https://mm.mmwp.net/wp-content ... 4.jpg 402w, https://mm.mmwp.net/wp-content ... 6.jpg 604w" />-----本页内容结束,喜欢请分享! -----

网站自动采集文章(SEO人员维再也不用烦劳来回来回切换网站后台反复登录后台)

采集交流 • 优采云 发表了文章 • 0 个评论 • 178 次浏览 • 2022-01-01 08:05

Q:免费的ZBLOGcms采集插件好用吗?小白写采集规则难吗?

答案:易于使用!导入关键词就可以了采集,不需要写采集规则。

问:如何安装免费的ZBLOGcms采集插件?

答案:不需要安装。插件是本地化软件,就像打开文档一样!

问:你能写多少文章采集文章

使用免费的Zblog插件一天使用

答案:每天至少采集百万文章(根据情况设置),不会影响服务器资源

问:如何使用免费的Zblog插件采集发布?

答:软件自带发布功能,采集后会自动发布。

问:可以应用多少个网站免费Zblog采集插件?

答案:如果使用N个网站,可以直接增加需要采集网站。

问:Zblog 有没有支持采集的版本?

答:ZBlog任何版本都可以使用,永远不会因为版本的原因用不了。

一、如何使用免费的ZBlong插件?

启动软件,将关键词导入采集文章即可。

可同时创建数十个或数百个采集任务(一个任务可支持上传1000个关键词)

二、如何使用免费的Zblog发布插件?

1、发布工具还支持Empire、Yiyou、ZBLOG、织梦、WP、PB、Apple、搜外等各大cms

2、通过ZBLOG批量发布管理工具,可以直接看到文章的发布数量,文章发布的数量,伪原创是否成功、发布网址等。支持除Zblog以外的所有主流cms平台。也可以设置定时发布(SEO人员在优化网站时可以设置定时发布文章,这样搜索引擎爬取的频率会更高,对于整个网站,会继续增加权重。一个网站的权重越高,以后被搜索到的机会就越大。)

永远不要担心网站过度管理! SEO人员再也不用来回切换网站后台,反复登录后台很痛苦

在这个内容为王的时代,SEO人员应该明白,大量的网站内容是支撑流量的基础。 关键词越多,排名越多,流量越大,但是原创文章难度太大,成本太高。很多网站无法维持每天大量的原创内容输出,所以更频繁。

为什么这么多人选择Zbog?

Z-Blog 是一个基于 ASP/PHP 平台的 网站 程序。 Z-Blog 具有丰富而强大的可定制性。作为一个cms系统,Z-Blog可以更方便的管理和扩展您的网站。首先,Zblog应用中心拥有大量的插件和模板,功能强大。只要你精通HTML+CSS+JS,就可以轻松创建漂亮的模板。只要懂ASP或PHP,就可以制作Z-Blog插件或主题模板,并集成Z-Blog应用中心功能,只需从后台下载你想要的主题模板和插件即可。

在SEO方面,WordPress可能比Zblog比Google有更大的优势,相反,百度的搜索优势会比WordPress更大。总之,WordPress的优化和推广取决于SEOer如何优化。其实并不是很多人说的程序的天性,而是更方便的Diy。最终效果取决于您的 SEO 级别和项目决策。

编辑器使用此工具批量管理不同的cms网站,不仅知道程序对SEO更友好,还大大提高了工作效率!看完这篇文章,如果觉得不错,不妨采集起来,或者送给需要的朋友同事!你的一举一动都会成为编辑源源不断的动力! 查看全部

网站自动采集文章(SEO人员维再也不用烦劳来回来回切换网站后台反复登录后台)

Q:免费的ZBLOGcms采集插件好用吗?小白写采集规则难吗?

答案:易于使用!导入关键词就可以了采集,不需要写采集规则。

问:如何安装免费的ZBLOGcms采集插件?

答案:不需要安装。插件是本地化软件,就像打开文档一样!

问:你能写多少文章采集文章

使用免费的Zblog插件一天使用

答案:每天至少采集百万文章(根据情况设置),不会影响服务器资源

问:如何使用免费的Zblog插件采集发布?

答:软件自带发布功能,采集后会自动发布。

问:可以应用多少个网站免费Zblog采集插件?

答案:如果使用N个网站,可以直接增加需要采集网站。

问:Zblog 有没有支持采集的版本?

答:ZBlog任何版本都可以使用,永远不会因为版本的原因用不了。

一、如何使用免费的ZBlong插件?

启动软件,将关键词导入采集文章即可。

可同时创建数十个或数百个采集任务(一个任务可支持上传1000个关键词)

二、如何使用免费的Zblog发布插件?

1、发布工具还支持Empire、Yiyou、ZBLOG、织梦、WP、PB、Apple、搜外等各大cms

2、通过ZBLOG批量发布管理工具,可以直接看到文章的发布数量,文章发布的数量,伪原创是否成功、发布网址等。支持除Zblog以外的所有主流cms平台。也可以设置定时发布(SEO人员在优化网站时可以设置定时发布文章,这样搜索引擎爬取的频率会更高,对于整个网站,会继续增加权重。一个网站的权重越高,以后被搜索到的机会就越大。)

永远不要担心网站过度管理! SEO人员再也不用来回切换网站后台,反复登录后台很痛苦

在这个内容为王的时代,SEO人员应该明白,大量的网站内容是支撑流量的基础。 关键词越多,排名越多,流量越大,但是原创文章难度太大,成本太高。很多网站无法维持每天大量的原创内容输出,所以更频繁。

为什么这么多人选择Zbog?

Z-Blog 是一个基于 ASP/PHP 平台的 网站 程序。 Z-Blog 具有丰富而强大的可定制性。作为一个cms系统,Z-Blog可以更方便的管理和扩展您的网站。首先,Zblog应用中心拥有大量的插件和模板,功能强大。只要你精通HTML+CSS+JS,就可以轻松创建漂亮的模板。只要懂ASP或PHP,就可以制作Z-Blog插件或主题模板,并集成Z-Blog应用中心功能,只需从后台下载你想要的主题模板和插件即可。

在SEO方面,WordPress可能比Zblog比Google有更大的优势,相反,百度的搜索优势会比WordPress更大。总之,WordPress的优化和推广取决于SEOer如何优化。其实并不是很多人说的程序的天性,而是更方便的Diy。最终效果取决于您的 SEO 级别和项目决策。

编辑器使用此工具批量管理不同的cms网站,不仅知道程序对SEO更友好,还大大提高了工作效率!看完这篇文章,如果觉得不错,不妨采集起来,或者送给需要的朋友同事!你的一举一动都会成为编辑源源不断的动力!

网站自动采集文章(【干货】如何选择合适的方式爬取数据(一) )

采集交流 • 优采云 发表了文章 • 0 个评论 • 208 次浏览 • 2022-01-01 01:12

)

一、前言

是的,Ao,火辣的蓝哥是四个我~

网络爬虫(又称网络蜘蛛、网络机器人)是按照一定的规则自动抓取万维网上信息的程序或脚本。其他不太常用的名称包括蚂蚁、自动索引、模拟器或蠕虫。 ------百度百科

说到人,爬虫是用来定期获取海量数据,然后进行处理和使用的。是大数据、金融、机器学习等必要的支撑条件之一。

目前一线城市,爬虫的薪资待遇都比较客观。后来晋升中高级爬虫工程师、数据分析师、大数据开发岗位等都是很好的过渡。

二、项目目标

这次介绍的项目不需要太复杂。最终目的是将帖子的每条评论爬取到数据库中,并更新数据,防止重复爬取、反爬取等措施。

三、项目准备

这部分主要介绍本文用到的工具、涉及的库、网页等信息。

软件:PyCharm

所需库:Scrapy、selenium、pymongo、user_agent、datetime

目标网站:

http://bbs.foodmate.net

插件:chromedriver(版本必须正确)

四、项目分析1、确定爬取的结构网站

简而言之:确定网站的加载方式,如何正确进入帖子逐级抓取数据,使用什么格式保存数据等

其次观察网站的层级结构,也就是如何按照版块一点一点的进入post页面。这对于这个爬虫任务来说非常重要,也是编写代码的主要部分。

2、如何选择正确的数据抓取方式?

目前我知道的爬取方法如下(不全,但比较常用):

1)请求框架:这个http库可以灵活的抓取需要的数据,简单但是过程有点繁琐,可以配合抓包工具来获取数据。但是需要确定headers和对应的请求参数,否则无法获取数据;很多app爬取,图片视频爬取,爬取停止,比较轻量灵活,高并发分布式部署也很灵活,功能可以更好的实现。

2)Scrapy框架:scrapy框架可以说是最常用的爬虫,也是最好用的爬虫框架。它有很多优点:scrapy 是异步的;采用更具可读性的 xpath 而不是常规的;强大的统计和日志系统;同时抓取不同的网址;支持shell模式,方便独立调试;支持编写中间件,方便编写一些统一的过滤器;它可以通过管道存储在数据库中,等等。这也是本次要介绍的框架(结合selenium库)文章。

五、项目实现1、第一步:确定网站的类型

先说明什么意思,看什么网站,首先看网站的加载方式,无论是静态加载,动态加载(js加载),还是其他方法;根据不同的加载方式需要不同的处理方式。然后我们观察了今天爬取的网站,发现这是一个按时间顺序排列的论坛。首先猜测是静态加载网站;我们开启了组织js加载的插件,如下图

刷新后发现是静态的网站(如果能正常加载就基本是静态加载了)

2、步骤二:确定层级关系

其次,我们今天要爬取的网站是美食论坛网站,它是静态加载的网站。在前面的分析中我们已经了解了,接下来是层次结构:

大概就是上面的过程,一共三个层次的渐进访问,然后到达post页面,如下图。

部分代码展示:

一级界面:

def parse(self, response):

self.logger.info("已进入网页!")

self.logger.info("正在获取版块列表!")

column_path_list = response.css('#ct > div.mn > div:nth-child(2) > div')[:-1]

for column_path in column_path_list:

col_paths = column_path.css('div > table > tbody > tr > td > div > a').xpath('@href').extract()

for path in col_paths:

block_url = response.urljoin(path)

yield scrapy.Request(

url=block_url,

callback=self.get_next_path,

)

辅助接口:

def get_next_path(self, response):

self.logger.info("已进入版块!")

self.logger.info("正在获取文章列表!")

if response.url == 'http://www.foodmate.net/know/':

pass

else:

try:

nums = response.css('#fd_page_bottom > div > label > span::text').extract_first().split(' ')[-2]

except:

nums = 1

for num in range(1, int(nums) + 1):

tbody_list = response.css('#threadlisttableid > tbody')

for tbody in tbody_list:

if 'normalthread' in str(tbody):

item = LunTanItem()

item['article_url'] = response.urljoin(

tbody.css('* > tr > th > a.s.xst').xpath('@href').extract_first())

item['type'] = response.css(

'#ct > div > div.bm.bml.pbn > div.bm_h.cl > h1 > a::text').extract_first()

item['title'] = tbody.css('* > tr > th > a.s.xst::text').extract_first()

item['spider_type'] = "论坛"

item['source'] = "食品论坛"

if item['article_url'] != 'http://bbs.foodmate.net/':

yield scrapy.Request(

url=item['article_url'],

callback=self.get_data,

meta={'item': item, 'content_info': []}

)

try:

callback_url = response.css('#fd_page_bottom > div > a.nxt').xpath('@href').extract_first()

callback_url = response.urljoin(callback_url)

yield scrapy.Request(

url=callback_url,

callback=self.get_next_path,

)

except IndexError:

pass

三级接口:

def get_data(self, response):

self.logger.info("正在爬取论坛数据!")

item = response.meta['item']

content_list = []

divs = response.xpath('//*[@id="postlist"]/div')

user_name = response.css('div > div.pi > div:nth-child(1) > a::text').extract()

publish_time = response.css('div.authi > em::text').extract()

floor = divs.css('* strong> a> em::text').extract()

s_id = divs.xpath('@id').extract()

for i in range(len(divs) - 1):

content = ''

try:

strong = response.css('#postmessage_' + s_id[i].split('_')[-1] + '').xpath('string(.)').extract()

for s in strong:

content += s.split(';')[-1].lstrip('\r\n')

datas = dict(content=content, # 内容

reply_id=0, # 回复的楼层,默认0

user_name=user_name[i], # ⽤户名

publish_time=publish_time[i].split('于 ')[-1], # %Y-%m-%d %H:%M:%S'

id='#' + floor[i], # 楼层

)

content_list.append(datas)

except IndexError:

pass

item['content_info'] = response.meta['content_info']

item['scrawl_time'] = datetime.now().strftime('%Y-%m-%d %H:%M:%S')

item['content_info'] += content_list

data_url = response.css('#ct > div.pgbtn > a').xpath('@href').extract_first()

if data_url != None:

data_url = response.urljoin(data_url)

yield scrapy.Request(

url=data_url,

callback=self.get_data,

meta={'item': item, 'content_info': item['content_info']}

)

else:

item['scrawl_time'] = datetime.now().strftime('%Y-%m-%d %H:%M:%S')

self.logger.info("正在存储!")

print('储存成功')

yield item

3、第三步:确定爬取方式

因为是静态网页,所以首先决定使用scrapy框架直接获取数据,经过初步测试,发现该方法确实可行。加了定时器限制爬取速度导致我被网站限制,并且网站从静态加载的网页改为:进入网页前动态加载网页验证算法,直接访问会被后台拒绝.

但是这种问题怎么会是我的小聪明呢?经过短暂的思考(1天),我将方案改为scrapy框架+selenium库的方法,通过调用chromedriver网站等模拟访问网站加载后,爬取会不完整。后续证明该方法确实可行且有效。

部分代码如下:

def process_request(self, request, spider):

chrome_options = Options()

chrome_options.add_argument('--headless') # 使用无头谷歌浏览器模式

chrome_options.add_argument('--disable-gpu')

chrome_options.add_argument('--no-sandbox')

# 指定谷歌浏览器路径

self.driver = webdriver.Chrome(chrome_options=chrome_options,

executable_path='E:/pycharm/workspace/爬虫/scrapy/chromedriver')

if request.url != 'http://bbs.foodmate.net/':

self.driver.get(request.url)

html = self.driver.page_source

time.sleep(1)

self.driver.quit()

return scrapy.http.HtmlResponse(url=request.url, body=html.encode('utf-8'), encoding='utf-8',

request=request)

4、第四步:确定爬取数据的存储格式

这部分不用说了,根据自己的需要在items.py中设置要爬取的数据格式。只需使用这种格式保存在项目中即可:

class LunTanItem(scrapy.Item):

"""

论坛字段

"""

title = Field() # str: 字符类型 | 论坛标题

content_info = Field() # str: list类型 | 类型list: [LunTanContentInfoItem1, LunTanContentInfoItem2]

article_url = Field() # str: url | 文章链接

scrawl_time = Field() # str: 时间格式 参照如下格式 2019-08-01 10:20:00 | 数据爬取时间

source = Field() # str: 字符类型 | 论坛名称 eg: 未名BBS, 水木社区, 天涯论坛

type = Field() # str: 字符类型 | 板块类型 eg: '财经', '体育', '社会'

spider_type = Field() # str: forum | 只能写 'forum'

5、第五步:确认保存数据库

本项目选用的数据库是mongodb。因为是非关系型数据库,优势明显,对格式要求没有那么高。可以灵活存储多维数据。一般是爬虫首选的数据库(别跟我说redis,我也会用,主要不会)

代码:

import pymongo

class FMPipeline():

def __init__(self):

super(FMPipeline, self).__init__()

# client = pymongo.MongoClient('139.217.92.75')

client = pymongo.MongoClient('localhost')

db = client.scrapy_FM

self.collection = db.FM

def process_item(self, item, spider):

query = {

'article_url': item['article_url']

}

self.collection.update_one(query, {"$set": dict(item)}, upsert=True)

return item

这时候,聪明的朋友会问:同一个数据爬两次怎么办? (换句话说,就是重复检查功能)

我之前没想过这个问题。后来问了大佬才知道。这是我们保存数据的时候做的,就这句话:

query = {

'article_url': item['article_url']

}

self.collection.update_one(query, {"$set": dict(item)}, upsert=True)

通过帖子链接判断是否存在数据爬取重复。如果重复,可以理解为覆盖,这样数据也可以更新。

6、其他设置

多线程、头、管道传输顺序等问题,都在settings.py文件中设置。详情请参考编辑器的项目查看。此处不再赘述。

七、效果展示

1、点击Run,控制台会显示结果,如下图。

2、 中间会有很多帖子在队列中爬取任务,然后多线程处理,我设置了16个线程,速度还是很可观的。

3、数据库展示:

Content_info 存储了每个帖子的所有评论以及相关用户的公开信息。

八、总结

1、本文文章主要向大家介绍食物网站的数据采集和存储过程,并详细讲解如何分析网页结构、爬取策略,网站类型、层级关系、抓取方式和数据存储程序,最终实现将帖子的每条评论抓取到数据库中,并更新数据防止重复抓取、反抓取等,干货已满。

2、 总的来说,这个项目并不是特别难。只要思路对了,数据规律找到了,可以说是轻而易举。这次介绍的水,希望能对大家有所帮助,是我最大的荣幸。

3、遇到问题,首先想到的不是问同事、朋友、老师,而是去谷歌、百度,看看有没有类似的情况,看看别人的经验,你必须学会自己发现和思考问题。 , 解决问题,这对以后的工作会有很大的帮助(之前有人说我没有离开我的学生时代,就是我喜欢问同事)。我在网上查了一些资料,还是没有头绪,再问别人。别人会更愿意帮你~

最后和大家分享我的座右铭:独立思考,不卑不亢。

结束

最后因为平台不支持外链

需要本文项目代码的小伙伴,请私信我的“代码”领取

需要更多资料和课件的小伙伴,请私信我的“资源”接收

如果您在操作过程中遇到任何问题,也可以在评论区讨论!

------------------- 结束-------------------

查看全部

网站自动采集文章(【干货】如何选择合适的方式爬取数据(一)

)

一、前言

是的,Ao,火辣的蓝哥是四个我~

网络爬虫(又称网络蜘蛛、网络机器人)是按照一定的规则自动抓取万维网上信息的程序或脚本。其他不太常用的名称包括蚂蚁、自动索引、模拟器或蠕虫。 ------百度百科

说到人,爬虫是用来定期获取海量数据,然后进行处理和使用的。是大数据、金融、机器学习等必要的支撑条件之一。

目前一线城市,爬虫的薪资待遇都比较客观。后来晋升中高级爬虫工程师、数据分析师、大数据开发岗位等都是很好的过渡。

二、项目目标

这次介绍的项目不需要太复杂。最终目的是将帖子的每条评论爬取到数据库中,并更新数据,防止重复爬取、反爬取等措施。

三、项目准备

这部分主要介绍本文用到的工具、涉及的库、网页等信息。

软件:PyCharm

所需库:Scrapy、selenium、pymongo、user_agent、datetime

目标网站:

http://bbs.foodmate.net

插件:chromedriver(版本必须正确)

四、项目分析1、确定爬取的结构网站

简而言之:确定网站的加载方式,如何正确进入帖子逐级抓取数据,使用什么格式保存数据等

其次观察网站的层级结构,也就是如何按照版块一点一点的进入post页面。这对于这个爬虫任务来说非常重要,也是编写代码的主要部分。

2、如何选择正确的数据抓取方式?

目前我知道的爬取方法如下(不全,但比较常用):

1)请求框架:这个http库可以灵活的抓取需要的数据,简单但是过程有点繁琐,可以配合抓包工具来获取数据。但是需要确定headers和对应的请求参数,否则无法获取数据;很多app爬取,图片视频爬取,爬取停止,比较轻量灵活,高并发分布式部署也很灵活,功能可以更好的实现。

2)Scrapy框架:scrapy框架可以说是最常用的爬虫,也是最好用的爬虫框架。它有很多优点:scrapy 是异步的;采用更具可读性的 xpath 而不是常规的;强大的统计和日志系统;同时抓取不同的网址;支持shell模式,方便独立调试;支持编写中间件,方便编写一些统一的过滤器;它可以通过管道存储在数据库中,等等。这也是本次要介绍的框架(结合selenium库)文章。

五、项目实现1、第一步:确定网站的类型

先说明什么意思,看什么网站,首先看网站的加载方式,无论是静态加载,动态加载(js加载),还是其他方法;根据不同的加载方式需要不同的处理方式。然后我们观察了今天爬取的网站,发现这是一个按时间顺序排列的论坛。首先猜测是静态加载网站;我们开启了组织js加载的插件,如下图

刷新后发现是静态的网站(如果能正常加载就基本是静态加载了)

2、步骤二:确定层级关系

其次,我们今天要爬取的网站是美食论坛网站,它是静态加载的网站。在前面的分析中我们已经了解了,接下来是层次结构:

大概就是上面的过程,一共三个层次的渐进访问,然后到达post页面,如下图。

部分代码展示:

一级界面:

def parse(self, response):

self.logger.info("已进入网页!")

self.logger.info("正在获取版块列表!")

column_path_list = response.css('#ct > div.mn > div:nth-child(2) > div')[:-1]

for column_path in column_path_list:

col_paths = column_path.css('div > table > tbody > tr > td > div > a').xpath('@href').extract()

for path in col_paths:

block_url = response.urljoin(path)

yield scrapy.Request(

url=block_url,

callback=self.get_next_path,

)

辅助接口:

def get_next_path(self, response):

self.logger.info("已进入版块!")

self.logger.info("正在获取文章列表!")

if response.url == 'http://www.foodmate.net/know/':

pass

else:

try:

nums = response.css('#fd_page_bottom > div > label > span::text').extract_first().split(' ')[-2]

except:

nums = 1

for num in range(1, int(nums) + 1):

tbody_list = response.css('#threadlisttableid > tbody')

for tbody in tbody_list:

if 'normalthread' in str(tbody):

item = LunTanItem()

item['article_url'] = response.urljoin(

tbody.css('* > tr > th > a.s.xst').xpath('@href').extract_first())

item['type'] = response.css(

'#ct > div > div.bm.bml.pbn > div.bm_h.cl > h1 > a::text').extract_first()

item['title'] = tbody.css('* > tr > th > a.s.xst::text').extract_first()

item['spider_type'] = "论坛"

item['source'] = "食品论坛"

if item['article_url'] != 'http://bbs.foodmate.net/':

yield scrapy.Request(

url=item['article_url'],

callback=self.get_data,

meta={'item': item, 'content_info': []}

)

try:

callback_url = response.css('#fd_page_bottom > div > a.nxt').xpath('@href').extract_first()

callback_url = response.urljoin(callback_url)

yield scrapy.Request(

url=callback_url,

callback=self.get_next_path,

)

except IndexError:

pass

三级接口:

def get_data(self, response):

self.logger.info("正在爬取论坛数据!")

item = response.meta['item']

content_list = []

divs = response.xpath('//*[@id="postlist"]/div')

user_name = response.css('div > div.pi > div:nth-child(1) > a::text').extract()

publish_time = response.css('div.authi > em::text').extract()

floor = divs.css('* strong> a> em::text').extract()

s_id = divs.xpath('@id').extract()

for i in range(len(divs) - 1):

content = ''

try:

strong = response.css('#postmessage_' + s_id[i].split('_')[-1] + '').xpath('string(.)').extract()

for s in strong:

content += s.split(';')[-1].lstrip('\r\n')

datas = dict(content=content, # 内容

reply_id=0, # 回复的楼层,默认0

user_name=user_name[i], # ⽤户名

publish_time=publish_time[i].split('于 ')[-1], # %Y-%m-%d %H:%M:%S'

id='#' + floor[i], # 楼层

)

content_list.append(datas)

except IndexError:

pass

item['content_info'] = response.meta['content_info']

item['scrawl_time'] = datetime.now().strftime('%Y-%m-%d %H:%M:%S')

item['content_info'] += content_list

data_url = response.css('#ct > div.pgbtn > a').xpath('@href').extract_first()

if data_url != None:

data_url = response.urljoin(data_url)

yield scrapy.Request(

url=data_url,

callback=self.get_data,

meta={'item': item, 'content_info': item['content_info']}

)

else:

item['scrawl_time'] = datetime.now().strftime('%Y-%m-%d %H:%M:%S')

self.logger.info("正在存储!")

print('储存成功')

yield item

3、第三步:确定爬取方式

因为是静态网页,所以首先决定使用scrapy框架直接获取数据,经过初步测试,发现该方法确实可行。加了定时器限制爬取速度导致我被网站限制,并且网站从静态加载的网页改为:进入网页前动态加载网页验证算法,直接访问会被后台拒绝.

但是这种问题怎么会是我的小聪明呢?经过短暂的思考(1天),我将方案改为scrapy框架+selenium库的方法,通过调用chromedriver网站等模拟访问网站加载后,爬取会不完整。后续证明该方法确实可行且有效。

部分代码如下:

def process_request(self, request, spider):

chrome_options = Options()

chrome_options.add_argument('--headless') # 使用无头谷歌浏览器模式

chrome_options.add_argument('--disable-gpu')

chrome_options.add_argument('--no-sandbox')

# 指定谷歌浏览器路径

self.driver = webdriver.Chrome(chrome_options=chrome_options,

executable_path='E:/pycharm/workspace/爬虫/scrapy/chromedriver')

if request.url != 'http://bbs.foodmate.net/':

self.driver.get(request.url)

html = self.driver.page_source

time.sleep(1)

self.driver.quit()

return scrapy.http.HtmlResponse(url=request.url, body=html.encode('utf-8'), encoding='utf-8',

request=request)

4、第四步:确定爬取数据的存储格式

这部分不用说了,根据自己的需要在items.py中设置要爬取的数据格式。只需使用这种格式保存在项目中即可:

class LunTanItem(scrapy.Item):

"""

论坛字段

"""

title = Field() # str: 字符类型 | 论坛标题

content_info = Field() # str: list类型 | 类型list: [LunTanContentInfoItem1, LunTanContentInfoItem2]

article_url = Field() # str: url | 文章链接

scrawl_time = Field() # str: 时间格式 参照如下格式 2019-08-01 10:20:00 | 数据爬取时间

source = Field() # str: 字符类型 | 论坛名称 eg: 未名BBS, 水木社区, 天涯论坛

type = Field() # str: 字符类型 | 板块类型 eg: '财经', '体育', '社会'

spider_type = Field() # str: forum | 只能写 'forum'

5、第五步:确认保存数据库

本项目选用的数据库是mongodb。因为是非关系型数据库,优势明显,对格式要求没有那么高。可以灵活存储多维数据。一般是爬虫首选的数据库(别跟我说redis,我也会用,主要不会)

代码:

import pymongo

class FMPipeline():

def __init__(self):

super(FMPipeline, self).__init__()

# client = pymongo.MongoClient('139.217.92.75')

client = pymongo.MongoClient('localhost')

db = client.scrapy_FM

self.collection = db.FM

def process_item(self, item, spider):

query = {

'article_url': item['article_url']

}

self.collection.update_one(query, {"$set": dict(item)}, upsert=True)

return item

这时候,聪明的朋友会问:同一个数据爬两次怎么办? (换句话说,就是重复检查功能)

我之前没想过这个问题。后来问了大佬才知道。这是我们保存数据的时候做的,就这句话:

query = {

'article_url': item['article_url']

}

self.collection.update_one(query, {"$set": dict(item)}, upsert=True)

通过帖子链接判断是否存在数据爬取重复。如果重复,可以理解为覆盖,这样数据也可以更新。

6、其他设置

多线程、头、管道传输顺序等问题,都在settings.py文件中设置。详情请参考编辑器的项目查看。此处不再赘述。

七、效果展示

1、点击Run,控制台会显示结果,如下图。

2、 中间会有很多帖子在队列中爬取任务,然后多线程处理,我设置了16个线程,速度还是很可观的。

3、数据库展示:

Content_info 存储了每个帖子的所有评论以及相关用户的公开信息。

八、总结

1、本文文章主要向大家介绍食物网站的数据采集和存储过程,并详细讲解如何分析网页结构、爬取策略,网站类型、层级关系、抓取方式和数据存储程序,最终实现将帖子的每条评论抓取到数据库中,并更新数据防止重复抓取、反抓取等,干货已满。

2、 总的来说,这个项目并不是特别难。只要思路对了,数据规律找到了,可以说是轻而易举。这次介绍的水,希望能对大家有所帮助,是我最大的荣幸。

3、遇到问题,首先想到的不是问同事、朋友、老师,而是去谷歌、百度,看看有没有类似的情况,看看别人的经验,你必须学会自己发现和思考问题。 , 解决问题,这对以后的工作会有很大的帮助(之前有人说我没有离开我的学生时代,就是我喜欢问同事)。我在网上查了一些资料,还是没有头绪,再问别人。别人会更愿意帮你~

最后和大家分享我的座右铭:独立思考,不卑不亢。

结束

最后因为平台不支持外链

需要本文项目代码的小伙伴,请私信我的“代码”领取

需要更多资料和课件的小伙伴,请私信我的“资源”接收

如果您在操作过程中遇到任何问题,也可以在评论区讨论!

------------------- 结束-------------------

网站自动采集文章(网站自动采集文章发布工具,你是想到网站上去找资源吗?)

采集交流 • 优采云 发表了文章 • 0 个评论 • 152 次浏览 • 2022-01-01 00:02

网站自动采集文章发布工具,可自动采集网站上的所有文章,下载热门文章。1.注册登录百度网盘,不注册不能下载2.搜索发现可找到用户分享的网盘链接3.点击4.回复“自动采集”5.点击“一键采集”跳转到“简书相似问题”5.选择“选题”6.编辑文章内容7.保存,

可以试试这款软件:直接输入网址即可采集网站上的任何文章,无需注册,不限制文章数量,

你是想到网站上去找资源吗?1.开源免费:v2ex、whois查询等网站网站上的所有文章(除色情、医疗、政治等敏感类文章)都可以采到2.需要购买正版(少数几个):站长通、网盘、数据劫持等。3.付费(排名靠前的几个):网盘api、个人网盘或企业网盘等。我们曾经采集过全网包括色情网站、医疗、政治类热门帖子,找到了一些关键词,请君自己去体会:;;。

可以用采集批量发布

百度站长,可以自动采集网站上所有的文章。

网址列表,

看看,现在开发者论坛,给他们技术支持,让他们去干活,他们会把他们想要的都填到代码中,开发一个程序,

因为有广告法。

基本的google搜索和用百度。 查看全部

网站自动采集文章(网站自动采集文章发布工具,你是想到网站上去找资源吗?)

网站自动采集文章发布工具,可自动采集网站上的所有文章,下载热门文章。1.注册登录百度网盘,不注册不能下载2.搜索发现可找到用户分享的网盘链接3.点击4.回复“自动采集”5.点击“一键采集”跳转到“简书相似问题”5.选择“选题”6.编辑文章内容7.保存,

可以试试这款软件:直接输入网址即可采集网站上的任何文章,无需注册,不限制文章数量,

你是想到网站上去找资源吗?1.开源免费:v2ex、whois查询等网站网站上的所有文章(除色情、医疗、政治等敏感类文章)都可以采到2.需要购买正版(少数几个):站长通、网盘、数据劫持等。3.付费(排名靠前的几个):网盘api、个人网盘或企业网盘等。我们曾经采集过全网包括色情网站、医疗、政治类热门帖子,找到了一些关键词,请君自己去体会:;;。

可以用采集批量发布

百度站长,可以自动采集网站上所有的文章。

网址列表,

看看,现在开发者论坛,给他们技术支持,让他们去干活,他们会把他们想要的都填到代码中,开发一个程序,

因为有广告法。

基本的google搜索和用百度。

网站自动采集文章(优采云自动文章采集器排名信息暂无排名或相关数据不充分备案信息)

采集交流 • 优采云 发表了文章 • 0 个评论 • 150 次浏览 • 2021-12-31 17:27

网站说明:优采云Auto文章采集器是一个press 关键词Auto采集 release网站文章@ >采集工具,免费提供1亿个关键词库,自动识别网页正文,无需编写采集规则,智能计算文章之间的相关性而关键词,NLP技术伪原创,指定采集的最新内容,指定采集目标网站,是必备的数据采集工具供网站管理员使用。

前往网站

体重信息

搜索引擎优化信息

百度来源:0~0 IP 移动来源:0~0 IP 出站链接:6 主页内部链接:16

收录信息

百度收录:14,200360收录:-神马收录:-搜狗收录:3,938Google收录:-

反链信息

百度反链:29,900360 反链:-神马反链:-搜狗反链:4,165 谷歌反链:-

排名信息

暂时没有排名或相关数据不足

记录信息

备案号:蜀ICP备14020125-4号 性质:人名:熊升 审稿时间:2018-11-22

域名信息

年龄:2016年8月20日时间:2015年4月11日

服务器信息

协议类型:HTTP/1.1 200 OK 页面类型:text/html; charset=UTF-8 服务器类型:NWS_SPmid 程序支持:-连接标识:-消息发送:2021年10月24日2小时47分05秒GZIP检测:未启用GZIP压缩源文件大小:25.76KB Compressed大小:启用GZIP,估计8.38KB压缩率:估计为67.48%最后修改时间:2021年10月23日20:10:00

网站评价

优采云Auto文章采集器-按关键词Auto采集发布网站文章采集工具由网友提交给顾云秒收录整理收录。 收录的时间是2021-12-31 14:52:28,目前已经有点击。 优采云Auto文章采集器-按关键词Auto采集发布工具的百度权重网站文章采集为0,百度收录有14200个,百度的路由约0~0个IP,备案号蜀ICP备14020125-4号,域名注册于2015年4月11日,已被6年 8 10月20日,本次测评结果仅供参考。 优采云Auto文章采集器-按关键词Auto采集发布网站文章采集的真实值该工具需要读者考虑实际情况。 查看全部

网站自动采集文章(优采云自动文章采集器排名信息暂无排名或相关数据不充分备案信息)

网站说明:优采云Auto文章采集器是一个press 关键词Auto采集 release网站文章@ >采集工具,免费提供1亿个关键词库,自动识别网页正文,无需编写采集规则,智能计算文章之间的相关性而关键词,NLP技术伪原创,指定采集的最新内容,指定采集目标网站,是必备的数据采集工具供网站管理员使用。

前往网站

体重信息

搜索引擎优化信息

百度来源:0~0 IP 移动来源:0~0 IP 出站链接:6 主页内部链接:16

收录信息

百度收录:14,200360收录:-神马收录:-搜狗收录:3,938Google收录:-

反链信息

百度反链:29,900360 反链:-神马反链:-搜狗反链:4,165 谷歌反链:-

排名信息

暂时没有排名或相关数据不足

记录信息

备案号:蜀ICP备14020125-4号 性质:人名:熊升 审稿时间:2018-11-22

域名信息

年龄:2016年8月20日时间:2015年4月11日

服务器信息

协议类型:HTTP/1.1 200 OK 页面类型:text/html; charset=UTF-8 服务器类型:NWS_SPmid 程序支持:-连接标识:-消息发送:2021年10月24日2小时47分05秒GZIP检测:未启用GZIP压缩源文件大小:25.76KB Compressed大小:启用GZIP,估计8.38KB压缩率:估计为67.48%最后修改时间:2021年10月23日20:10:00

网站评价

优采云Auto文章采集器-按关键词Auto采集发布网站文章采集工具由网友提交给顾云秒收录整理收录。 收录的时间是2021-12-31 14:52:28,目前已经有点击。 优采云Auto文章采集器-按关键词Auto采集发布工具的百度权重网站文章采集为0,百度收录有14200个,百度的路由约0~0个IP,备案号蜀ICP备14020125-4号,域名注册于2015年4月11日,已被6年 8 10月20日,本次测评结果仅供参考。 优采云Auto文章采集器-按关键词Auto采集发布网站文章采集的真实值该工具需要读者考虑实际情况。

网站自动采集文章(网站自动采集文章赚钱,是好事但要有合理的盈利模式)

采集交流 • 优采云 发表了文章 • 0 个评论 • 149 次浏览 • 2021-12-22 07:00

网站自动采集文章赚钱,是好事但要有合理的盈利模式。为此,专门建一个qq交流群。聊一聊,您可以获得以下信息:1,千聊,一直播上天猫上上的各种商品文章,你是怎么搜集的?有没有转换成直播讲解?2,赚钱类网站,里面到底有没有商品,如果没有,就是瞎聊。有没有能赚钱的人给咱们转,或者说咱们能加入?大佬或者说你擅长什么,转发就送你了。

3,你在知乎上,在得到里,在得到专栏里,有没有你的关注,有没有获得某个专栏文章转载一次30块,没转载一次10块的活动,我也不知道现在还在不在?4,行家大咖经常性回答别人的问题,有没有老师愿意给我支付一笔稿费?5,答题者回答过的题目,是不是都有答案,我这里提供一份百度文库,如果百度文库上面有的问题你都能解决,一个价格20块。

6,有没有人会在知乎,得到上开一个专栏,然后这里有没有写答案,有没有专栏,有没有解答别人的问题,都一一提供,我会不会开专栏,开多少专栏?7,其他如何利用网站自动采集软件,如何赚钱,如何看店铺里面的爆款文章,这些信息都是什么?现在可以预知一个项目在起步中,不过效果如何,你应该清楚了。很多东西不是看多少书,学多少东西可以完全解决的,都是你走过的路,阅历过的场景,和你对这些场景的思考所得。

你缺的就是这个。千聊,一直播,天猫等,自己去提炼和总结吧。你会发现,都是这些网站自己的文章,但是,他们看到的文章,却可以按照采集软件的规则,做成下面的这种模板,他们可以不断去总结提炼这种模板,为什么可以成为爆款?因为他们其实就是这样采集网站采集文章的。可以看出来,他们可以看,但并不能为你创造收益。 查看全部

网站自动采集文章(网站自动采集文章赚钱,是好事但要有合理的盈利模式)

网站自动采集文章赚钱,是好事但要有合理的盈利模式。为此,专门建一个qq交流群。聊一聊,您可以获得以下信息:1,千聊,一直播上天猫上上的各种商品文章,你是怎么搜集的?有没有转换成直播讲解?2,赚钱类网站,里面到底有没有商品,如果没有,就是瞎聊。有没有能赚钱的人给咱们转,或者说咱们能加入?大佬或者说你擅长什么,转发就送你了。

3,你在知乎上,在得到里,在得到专栏里,有没有你的关注,有没有获得某个专栏文章转载一次30块,没转载一次10块的活动,我也不知道现在还在不在?4,行家大咖经常性回答别人的问题,有没有老师愿意给我支付一笔稿费?5,答题者回答过的题目,是不是都有答案,我这里提供一份百度文库,如果百度文库上面有的问题你都能解决,一个价格20块。

6,有没有人会在知乎,得到上开一个专栏,然后这里有没有写答案,有没有专栏,有没有解答别人的问题,都一一提供,我会不会开专栏,开多少专栏?7,其他如何利用网站自动采集软件,如何赚钱,如何看店铺里面的爆款文章,这些信息都是什么?现在可以预知一个项目在起步中,不过效果如何,你应该清楚了。很多东西不是看多少书,学多少东西可以完全解决的,都是你走过的路,阅历过的场景,和你对这些场景的思考所得。

你缺的就是这个。千聊,一直播,天猫等,自己去提炼和总结吧。你会发现,都是这些网站自己的文章,但是,他们看到的文章,却可以按照采集软件的规则,做成下面的这种模板,他们可以不断去总结提炼这种模板,为什么可以成为爆款?因为他们其实就是这样采集网站采集文章的。可以看出来,他们可以看,但并不能为你创造收益。

网站自动采集文章(网站自动采集文章和关键词对公司网站有着很大的意义)

采集交流 • 优采云 发表了文章 • 0 个评论 • 146 次浏览 • 2021-12-22 04:02

网站自动采集文章和关键词对公司网站有着很大的意义,知乎总统上有一位资深的高手曾说过,在互联网上中心思想是你要赚钱!没有人管你是不是完全原创,是不是你所说的事情本身是假的,是不是每个人都在说话。并且在信息量过剩的时代这些是非常的可怕的。网站本身自带的搜索引擎,对于我们的网站来说自动采集信息具有很大的意义!实例:前段时间收到了一条来自网站自动采集的信息,“是不是他开了个网店”然后我就在百度、谷歌等搜索引擎搜索了,居然什么都没有!然后立马联系了一下他,我说我们网站有保留这条信息,然后跟他确认下对方是否有发表过!对方居然说“他没有”我当时很纳闷,于是又咨询了他们。

对方给我的理由是:有什么问题可以去问,没有问题可以不发布到网站,对方提供的信息是真实可靠的。就这么简单!好像还没想到如何去验证这是不是个骗局,也不管他的来源网站是否真实,现在就是那边有来源信息我们也需要去采集。毕竟在互联网上采集信息对我们网站是有意义的,不知道这样骗人有没有道德!。

正常来说如果不经过作者确认的话,自动采集的信息,肯定是有问题的。但是你可以说,这是一条新闻、一个评论,有什么害怕的?说到底,自动采集还是为了市场:不需要安装任何插件,就可以提取信息。但是,即使用软件,也是需要seo功底的,如果你想在那上面盈利的话,就看你自己的智慧和能力了。一般说来,这些人技术都是比较牛逼的,每天查询的量也比较大,并且他们抓到的内容,大部分也是未经过作者同意的,作者只要告诉他们来源,他们就可以去采集。

很多网站,甚至什么平台,都有这样的采集者。于是你还能看到“熊猫看书”“豆瓣书房”。这样的平台,叫做“seo工具采集”。 查看全部

网站自动采集文章(网站自动采集文章和关键词对公司网站有着很大的意义)

网站自动采集文章和关键词对公司网站有着很大的意义,知乎总统上有一位资深的高手曾说过,在互联网上中心思想是你要赚钱!没有人管你是不是完全原创,是不是你所说的事情本身是假的,是不是每个人都在说话。并且在信息量过剩的时代这些是非常的可怕的。网站本身自带的搜索引擎,对于我们的网站来说自动采集信息具有很大的意义!实例:前段时间收到了一条来自网站自动采集的信息,“是不是他开了个网店”然后我就在百度、谷歌等搜索引擎搜索了,居然什么都没有!然后立马联系了一下他,我说我们网站有保留这条信息,然后跟他确认下对方是否有发表过!对方居然说“他没有”我当时很纳闷,于是又咨询了他们。

对方给我的理由是:有什么问题可以去问,没有问题可以不发布到网站,对方提供的信息是真实可靠的。就这么简单!好像还没想到如何去验证这是不是个骗局,也不管他的来源网站是否真实,现在就是那边有来源信息我们也需要去采集。毕竟在互联网上采集信息对我们网站是有意义的,不知道这样骗人有没有道德!。

正常来说如果不经过作者确认的话,自动采集的信息,肯定是有问题的。但是你可以说,这是一条新闻、一个评论,有什么害怕的?说到底,自动采集还是为了市场:不需要安装任何插件,就可以提取信息。但是,即使用软件,也是需要seo功底的,如果你想在那上面盈利的话,就看你自己的智慧和能力了。一般说来,这些人技术都是比较牛逼的,每天查询的量也比较大,并且他们抓到的内容,大部分也是未经过作者同意的,作者只要告诉他们来源,他们就可以去采集。

很多网站,甚至什么平台,都有这样的采集者。于是你还能看到“熊猫看书”“豆瓣书房”。这样的平台,叫做“seo工具采集”。

网站自动采集文章(网站自动采集文章标题及描述,有两个关键点需要去做)

采集交流 • 优采云 发表了文章 • 0 个评论 • 210 次浏览 • 2021-12-22 02:00

网站自动采集文章标题及描述。

无论是app开发还是商城,pc端页面采集是很多采集者感兴趣的问题。不同网站之间的url对应关系和收录策略都有不同。关于去重,有两个关键点需要去做:1、url根据页面内容,分成小类别,分别列表页、主题页,按照pc、app等重要性来安排url;2、去重时通过在线数据统计去除重复页面。

freebuf网站的去重,比如什么app,什么购物网站,什么文章,总结起来就一句话:app和购物网站对主要页面及页面内容进行去重,文章内容不变。

本人也在从事app开发,目前对于做客户端app的话,页面采集到底是采用哪些方法最有效果呢?关注网络爬虫框架百川源(维小图)帮你解决。

不会!

不会的

从第三方采集的内容,在其他网站上进行过转存,与某个网站本身的数据相同的就认为同一篇。而且现在也有很多的防爬网站,如百度站长平台采集软件可以去查看,内容达到量级效果很明显。

无论是网站还是app,对app端都是存在去重的问题,就是app上每一篇url与原有网站上的内容,存在明显的差异,这点对于app去重是一种降低app内容非正常下载次数,提高用户体验,达到对原网站内容一次性下载的效果。 查看全部

网站自动采集文章(网站自动采集文章标题及描述,有两个关键点需要去做)

网站自动采集文章标题及描述。

无论是app开发还是商城,pc端页面采集是很多采集者感兴趣的问题。不同网站之间的url对应关系和收录策略都有不同。关于去重,有两个关键点需要去做:1、url根据页面内容,分成小类别,分别列表页、主题页,按照pc、app等重要性来安排url;2、去重时通过在线数据统计去除重复页面。

freebuf网站的去重,比如什么app,什么购物网站,什么文章,总结起来就一句话:app和购物网站对主要页面及页面内容进行去重,文章内容不变。

本人也在从事app开发,目前对于做客户端app的话,页面采集到底是采用哪些方法最有效果呢?关注网络爬虫框架百川源(维小图)帮你解决。

不会!

不会的

从第三方采集的内容,在其他网站上进行过转存,与某个网站本身的数据相同的就认为同一篇。而且现在也有很多的防爬网站,如百度站长平台采集软件可以去查看,内容达到量级效果很明显。

无论是网站还是app,对app端都是存在去重的问题,就是app上每一篇url与原有网站上的内容,存在明显的差异,这点对于app去重是一种降低app内容非正常下载次数,提高用户体验,达到对原网站内容一次性下载的效果。

网站自动采集文章(别拿别人的光环套在自己头上“↓↓” )

采集交流 • 优采云 发表了文章 • 0 个评论 • 165 次浏览 • 2021-12-15 09:14

)

请不要相信那些低价出售但一直说软件和我的一样的人。如果你自己的软件卖不出去便宜,你说和我的一样也没关系。我想问一下,这个软件估计你不会用吧!你可以复制我的描述,但你能复制我们的服务吗?我们7*12小时为客户服务。你哀悼你,“我劝你说”不要把别人的光环放在自己身上”

↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓

小三跑了

,老板开心,让老板送你礼物

24小时内获得好评的1000人升级高级VIP团套餐

也发到汇龙营销站

小三跑了

,老板开心,让老板送你礼物

终身高级VIP会员,本站软件数量:(咨询专区)基本涵盖市面上所有营销软件!

现在网上销售的产品几乎没有一个可以在win7系统上运行的,我们的还可以。这就是区别

免责声明:其他商店的软件便宜几美元。请注意,我们的软件是2013最新乱版,注册码注册使用。和正式版一样,部分店家软件暴力,也可以拿2011 Impersonation,阉割很多功能,最好的百度对接优化大打折扣。我们不比价格,多几块钱用得安心。!!!!对于 2011 版本,我们免费发送@。不要为了节省那几美元而购买不能使用的东西。我们全职做软件。看看店里的其他宝物你就知道了!!

凡购买本软件均收录升级后服务,并且是唯一提供后续升级的商家!~我多年的技术支持

升级说明详细学习预览地址:

田(博君)伪原创工具2013混沌版-介绍:

文字伪原创+英文伪原创(目前已加入英文同顺模式,流畅度堪比TBS)

本期的主角是博骏SEO伪原创工具。是天天SEO伪原创 Tool的第三代产品。天天SEO伪原创工具是国内第一款伪原创工具。它诞生于2008年8月,从此中国站长有了自己的伪原创工具。它的出现简化了网站管理员为迎合搜索引擎而进行的繁重的手动伪原创工作。一切以用户需求为出发点,一切以文章同顺为出发点,不断更新软件。目前伪原创工具已经进入第三代,正式更名为:博骏SEO伪原创软件。车博君伪原创的工具经过不断的升级完善,从2010版升级到2011版。

《博骏SEO伪原创工具2011版》-是专门为搜索引擎开发的修改文章的工具。在内容为“王”的时代是家喻户晓的。引擎比原创更重要。如果有原创,就会有排名!

功能:1.这个伪原创工具是一个实用的SEOER工具,是生成原创和伪原创文章的工具,使用伪原创网上复制的工具文章可以瞬间变成原创文章。

适用范围:si-fu类网站(不用担心找不到原创);网赚类(获得高收录金额);门户类(编辑文章更有效率)企业类(提升排名)。(文章收录率99%) 因为专业,所以功能强大【功能:增加百度收录的使用量!加快百度快照更新频率!快速提升网站排名!】

使用效果:文章更新频率快,文章原创性高,搜索引擎蜘蛛一天来2~3次。收录 率极高。网站 快照经常更新。权重增长迅速,排名也迅速上升。尤其对于百度来说,百度不像谷歌那样重视外联。对于竞争激烈的关键词,最好更新一下原创文章,保持网站的“活力”,这样排名事半功倍。(增加了自动采集、自动原创、自动入库、无限自定义词库功能。)全面支持中文伪原创和英文文章伪原创。

本店承诺店主所做的一定是最认真的卖家,会尽全力帮您安装调试,谢谢您的光临!

郑重说明:由于软件的可复制性,售出的产品不接受退款。如软件无法正常安装,本店承诺全额退款。本产品低价出售,不接受差评。喜欢讨价还价的买家请绕道。一旦差评,本店将投诉到底,绝不容忍!

1.加入云词典加载

2.批处理伪原创、伪原创支持优采云指定文件夹中指定文件类型的数据库批处理!

3. 混沌一代!彻底的KO机器识别。

4.脚本支持可以编写任意脚本进行批量更新网站。

5.自定义本地词库支持中英双语词库 支持词库5个,词库总数约20万个!

另外,本店编译的本地词库达到了9W+,更超值!!

6.数据库伪原创支持ACCESS MYSQL MSSQL支持。

查看全部

网站自动采集文章(别拿别人的光环套在自己头上“↓↓”

)

请不要相信那些低价出售但一直说软件和我的一样的人。如果你自己的软件卖不出去便宜,你说和我的一样也没关系。我想问一下,这个软件估计你不会用吧!你可以复制我的描述,但你能复制我们的服务吗?我们7*12小时为客户服务。你哀悼你,“我劝你说”不要把别人的光环放在自己身上”

↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓↓

小三跑了

,老板开心,让老板送你礼物

24小时内获得好评的1000人升级高级VIP团套餐

也发到汇龙营销站

小三跑了

,老板开心,让老板送你礼物

终身高级VIP会员,本站软件数量:(咨询专区)基本涵盖市面上所有营销软件!

现在网上销售的产品几乎没有一个可以在win7系统上运行的,我们的还可以。这就是区别

免责声明:其他商店的软件便宜几美元。请注意,我们的软件是2013最新乱版,注册码注册使用。和正式版一样,部分店家软件暴力,也可以拿2011 Impersonation,阉割很多功能,最好的百度对接优化大打折扣。我们不比价格,多几块钱用得安心。!!!!对于 2011 版本,我们免费发送@。不要为了节省那几美元而购买不能使用的东西。我们全职做软件。看看店里的其他宝物你就知道了!!

凡购买本软件均收录升级后服务,并且是唯一提供后续升级的商家!~我多年的技术支持

升级说明详细学习预览地址:

田(博君)伪原创工具2013混沌版-介绍:

文字伪原创+英文伪原创(目前已加入英文同顺模式,流畅度堪比TBS)

本期的主角是博骏SEO伪原创工具。是天天SEO伪原创 Tool的第三代产品。天天SEO伪原创工具是国内第一款伪原创工具。它诞生于2008年8月,从此中国站长有了自己的伪原创工具。它的出现简化了网站管理员为迎合搜索引擎而进行的繁重的手动伪原创工作。一切以用户需求为出发点,一切以文章同顺为出发点,不断更新软件。目前伪原创工具已经进入第三代,正式更名为:博骏SEO伪原创软件。车博君伪原创的工具经过不断的升级完善,从2010版升级到2011版。

《博骏SEO伪原创工具2011版》-是专门为搜索引擎开发的修改文章的工具。在内容为“王”的时代是家喻户晓的。引擎比原创更重要。如果有原创,就会有排名!

功能:1.这个伪原创工具是一个实用的SEOER工具,是生成原创和伪原创文章的工具,使用伪原创网上复制的工具文章可以瞬间变成原创文章。

适用范围:si-fu类网站(不用担心找不到原创);网赚类(获得高收录金额);门户类(编辑文章更有效率)企业类(提升排名)。(文章收录率99%) 因为专业,所以功能强大【功能:增加百度收录的使用量!加快百度快照更新频率!快速提升网站排名!】

使用效果:文章更新频率快,文章原创性高,搜索引擎蜘蛛一天来2~3次。收录 率极高。网站 快照经常更新。权重增长迅速,排名也迅速上升。尤其对于百度来说,百度不像谷歌那样重视外联。对于竞争激烈的关键词,最好更新一下原创文章,保持网站的“活力”,这样排名事半功倍。(增加了自动采集、自动原创、自动入库、无限自定义词库功能。)全面支持中文伪原创和英文文章伪原创。

本店承诺店主所做的一定是最认真的卖家,会尽全力帮您安装调试,谢谢您的光临!

郑重说明:由于软件的可复制性,售出的产品不接受退款。如软件无法正常安装,本店承诺全额退款。本产品低价出售,不接受差评。喜欢讨价还价的买家请绕道。一旦差评,本店将投诉到底,绝不容忍!

1.加入云词典加载

2.批处理伪原创、伪原创支持优采云指定文件夹中指定文件类型的数据库批处理!

3. 混沌一代!彻底的KO机器识别。

4.脚本支持可以编写任意脚本进行批量更新网站。

5.自定义本地词库支持中英双语词库 支持词库5个,词库总数约20万个!

另外,本店编译的本地词库达到了9W+,更超值!!

6.数据库伪原创支持ACCESS MYSQL MSSQL支持。

网站自动采集文章(河北保定seo优采云采集文章发布苹果cms教程免费关键词排名优化相关内容)

采集交流 • 优采云 发表了文章 • 0 个评论 • 162 次浏览 • 2021-12-13 20:28

保定搜索引擎优化

优采云采集文章 发布苹果cms 教程

免费关键词排名优化相关内容(一)

前面我们说过网站根据百度搜索引擎不断爬取的自然排名,收录会导致你的网站排名不稳定,但是对于那些自己网站@ > 权重网站内容高、内容优秀的排名不太可能受到影响。那么搜索引擎如何判断网站的权限,会从网站域名、网页网址在线时间、用户点击次数、网站验证等方面判断

NO.1 谷歌搜索:谷歌是全球最大的搜索引擎,谷歌成立于1998年9月,创始人是拉里佩奇和谢尔盖布里。日均ip访问量3.2亿,日均pv浏览量25亿。33%的访问者来自美国,4.9%来自中国(主要网站)。

你知道怎么做SEO吗?很多人说做SEO的标准是要不要做外链。外链的常识虽然是SEO中的一个链接,但是也可以看出外链在SEO中的重要性。然而,外链长期的机械运转,总会让人感到疲倦,甚至扭曲人生价值观。难道我只能做外部链接?这就是为什么有“买外链”想法的买家出现了,由此诞生了外链卖家。而价格多低多低,更是抢眼,一个月几十块钱的外链随处可见。

但是,全国真的有这么便宜的午餐吗?120块1700块,如果纯手工出版,就算这个人做的很熟练,一天170块也会死,那么十天120块的收入,早就饿死了!生活中没有规律!

套路一:“我们的外链有用,没用,只能说你的网站优化太差了!” 事实上,A5在8年的SEO诊断过程中已经有很多网站。@>网站上的SEO很糟糕,但排名还是不错的。为什么?因为外部链接很弱!虽然由于网站问题排名比较不理想,但不会继续发布。链将根本不起作用。

套路二:“谁说我们收录了百度词条?我们收录了搜索引擎词条,不是360词条吗?” 大家都知道360进入规则有多松,站群站可以轻松进入。我发了这样的作弊链接,进了360,但是你考虑过百度吗?很多非法链接不仅无法提升排名,还直接导致网站被破解定制作弊!

A5SEO项目经理何桂江建议:低成本的外链决定了人们不可能“发布外链”,这样的外链都是以站群的形式发布的。有的人把站群当作SF,有的人把站群当作外链。不同的是后者不违法,不会收到盒饭。

让我们来看看上面的图片。有9000多个站点,这太可怕了。我们想说的是:在这 9000 个站点中,可以有 100 个具有权重的站点。其次,价格一定很高。那么其他的 8,900 呢?何桂江在这里想说的是:任何权重值都是第三方对事物的定义,而不是搜索引擎。误刷新后,一个高权重的网站可以瞬间刷新(实际上没有效果)。绝大多数人不明白什么是真正的排名,如果还虚伪就付出代价!

A5SEO项目经理何桂江忠告:排名来之不易,没有人会为了小利而献身于网站的美好未来,更何况网站权重越高,收益越多,远非销售,如何点击链接 诱人而充满活力。当然,确实有一些网站的卖链接(输入一些内鬼钱包)。如果你有一双引人注目的眼睛,你可以找到它。

最后,有一个像上图这样的视频链接。关于视频链接,我们可以说这样的链接是100%有效的,但基本上100%的网站播放没用!为什么?? 优酷、新浪、土豆、搜狐、腾讯等视频网站的权重都非常高,所以如果你在这些页面上留下外链,你会得到很好的内链权重。但为什么它降低了功率?排在榜首的是投机,降低了外链的人工成本,扰乱了搜索规则。其次,这些频道是电影和视频网站的集合对象。你可以发一个链接,第二天就会变成3000个。谁的网站能达到这样的暴涨?搜索引擎不处理,没人管你。谁来处理?

A5SEO项目经理何桂江建议:百度资源频道以前可以手动处理一些不正确的链接,但现在没有那么简单了。虽然比较“聪明”,一般的链接不能醒目,但是在某些方面还是有很多不足。如果发了不合适的链接,如果是批量输入的,暴涨无法处理,那就等死吧!说点别的吧,我发现网站在很短的时间内就出现了当时的问题。出问题后,反响非常好。很有用,所以站长不用担心有人故意这样做来摆脱链条网站。

A5 Marketing在提交“网站SEO诊断解决方案”时,会在声明中强调停止购买外链的原因同上!这个业务太深了,除非你有扎实的知识基础知识,否则外链上的小船会被掀翻。

seo中meta标签的三大要素是什么

头条文章采集发布相关内容(二)

如果你的产品质量够硬,那就用

seo和sem的关系

网站优化seo公司

关键词 seo 页面标题中的相关内容(三) 查看全部

网站自动采集文章(河北保定seo优采云采集文章发布苹果cms教程免费关键词排名优化相关内容)

保定搜索引擎优化

优采云采集文章 发布苹果cms 教程

免费关键词排名优化相关内容(一)

前面我们说过网站根据百度搜索引擎不断爬取的自然排名,收录会导致你的网站排名不稳定,但是对于那些自己网站@ > 权重网站内容高、内容优秀的排名不太可能受到影响。那么搜索引擎如何判断网站的权限,会从网站域名、网页网址在线时间、用户点击次数、网站验证等方面判断

NO.1 谷歌搜索:谷歌是全球最大的搜索引擎,谷歌成立于1998年9月,创始人是拉里佩奇和谢尔盖布里。日均ip访问量3.2亿,日均pv浏览量25亿。33%的访问者来自美国,4.9%来自中国(主要网站)。

你知道怎么做SEO吗?很多人说做SEO的标准是要不要做外链。外链的常识虽然是SEO中的一个链接,但是也可以看出外链在SEO中的重要性。然而,外链长期的机械运转,总会让人感到疲倦,甚至扭曲人生价值观。难道我只能做外部链接?这就是为什么有“买外链”想法的买家出现了,由此诞生了外链卖家。而价格多低多低,更是抢眼,一个月几十块钱的外链随处可见。

但是,全国真的有这么便宜的午餐吗?120块1700块,如果纯手工出版,就算这个人做的很熟练,一天170块也会死,那么十天120块的收入,早就饿死了!生活中没有规律!

套路一:“我们的外链有用,没用,只能说你的网站优化太差了!” 事实上,A5在8年的SEO诊断过程中已经有很多网站。@>网站上的SEO很糟糕,但排名还是不错的。为什么?因为外部链接很弱!虽然由于网站问题排名比较不理想,但不会继续发布。链将根本不起作用。

套路二:“谁说我们收录了百度词条?我们收录了搜索引擎词条,不是360词条吗?” 大家都知道360进入规则有多松,站群站可以轻松进入。我发了这样的作弊链接,进了360,但是你考虑过百度吗?很多非法链接不仅无法提升排名,还直接导致网站被破解定制作弊!

A5SEO项目经理何桂江建议:低成本的外链决定了人们不可能“发布外链”,这样的外链都是以站群的形式发布的。有的人把站群当作SF,有的人把站群当作外链。不同的是后者不违法,不会收到盒饭。

让我们来看看上面的图片。有9000多个站点,这太可怕了。我们想说的是:在这 9000 个站点中,可以有 100 个具有权重的站点。其次,价格一定很高。那么其他的 8,900 呢?何桂江在这里想说的是:任何权重值都是第三方对事物的定义,而不是搜索引擎。误刷新后,一个高权重的网站可以瞬间刷新(实际上没有效果)。绝大多数人不明白什么是真正的排名,如果还虚伪就付出代价!

A5SEO项目经理何桂江忠告:排名来之不易,没有人会为了小利而献身于网站的美好未来,更何况网站权重越高,收益越多,远非销售,如何点击链接 诱人而充满活力。当然,确实有一些网站的卖链接(输入一些内鬼钱包)。如果你有一双引人注目的眼睛,你可以找到它。

最后,有一个像上图这样的视频链接。关于视频链接,我们可以说这样的链接是100%有效的,但基本上100%的网站播放没用!为什么?? 优酷、新浪、土豆、搜狐、腾讯等视频网站的权重都非常高,所以如果你在这些页面上留下外链,你会得到很好的内链权重。但为什么它降低了功率?排在榜首的是投机,降低了外链的人工成本,扰乱了搜索规则。其次,这些频道是电影和视频网站的集合对象。你可以发一个链接,第二天就会变成3000个。谁的网站能达到这样的暴涨?搜索引擎不处理,没人管你。谁来处理?

A5SEO项目经理何桂江建议:百度资源频道以前可以手动处理一些不正确的链接,但现在没有那么简单了。虽然比较“聪明”,一般的链接不能醒目,但是在某些方面还是有很多不足。如果发了不合适的链接,如果是批量输入的,暴涨无法处理,那就等死吧!说点别的吧,我发现网站在很短的时间内就出现了当时的问题。出问题后,反响非常好。很有用,所以站长不用担心有人故意这样做来摆脱链条网站。

A5 Marketing在提交“网站SEO诊断解决方案”时,会在声明中强调停止购买外链的原因同上!这个业务太深了,除非你有扎实的知识基础知识,否则外链上的小船会被掀翻。

seo中meta标签的三大要素是什么

头条文章采集发布相关内容(二)

如果你的产品质量够硬,那就用

seo和sem的关系

网站优化seo公司

关键词 seo 页面标题中的相关内容(三)

网站自动采集文章(网站自动采集文章有哪些技巧?文库工作者们是如何抓住自动抓取的技巧)

采集交流 • 优采云 发表了文章 • 0 个评论 • 152 次浏览 • 2021-12-11 11:01

网站自动采集文章有哪些技巧?今天看看文库工作者们是如何抓住自动抓取的技巧,自动抓取文章有以下技巧,帮助商家直接抓取文章,解决了人工编辑过程中错误数据被覆盖的情况,用过的都说好。

1、关键词自动抓取技巧:根据或,要抓取的网站/文章标题/或者类目/等关键词,到百度统计或者百度文库titlesegment进行分析,抓取效果非常好。

2、固定抓取关键词技巧:如果网站或者文库内容搜索数量较多,比如5万篇网站或者几十万篇,可能抓取文章太困难,但如果找到一个抓取效果好的关键词,再去到百度统计里自动抓取,抓取效果就好太多。

3、多栏自动抓取技巧:在一个网站或者文库内有多栏分类,可能需要抓取多篇文章,一般我们可以通过页面来判断文章抓取是否方便,如果页面文章以分类为单位或者以大多数网站为参考,抓取就方便,以网站为单位就会有分页样式,如:如果是4个栏可以抓取,假如文章数量为2万篇或者总页数为2万篇,可以尝试先抓取文章,然后再到网站或者文库去找其它的文章,或者有时也可以先抓取文章再到百度统计里自动抓取其它页面,以确保成功抓取,这样页面不仅可以有你第一次留下来的页面,还能更新文章页面上的文章。

4、whatweb自动抓取技巧:whatweb全网抓取文章,自动过滤编辑后的文章。

5、wordweb自动抓取技巧:wordweb全网抓取文章,自动过滤编辑后的文章。小编认为最重要的是抓取能力,抓取能力不足,再好的技巧,抓取不到好的结果,不是浪费时间而是错失机会。抓取不到好的结果就意味着抓取出现问题,问题发现不及时就再抓取的过程中,重复一遍一遍,最后抓取问题没有解决还浪费时间,抓取不到好的结果就意味着抓取出现问题,问题发现不及时就再抓取的过程中,重复一遍一遍,最后抓取问题没有解决还浪费时间,抓取不到好的结果就意味着抓取出现问题,更多精彩文章可登录jing.xyz网站。 查看全部

网站自动采集文章(网站自动采集文章有哪些技巧?文库工作者们是如何抓住自动抓取的技巧)

网站自动采集文章有哪些技巧?今天看看文库工作者们是如何抓住自动抓取的技巧,自动抓取文章有以下技巧,帮助商家直接抓取文章,解决了人工编辑过程中错误数据被覆盖的情况,用过的都说好。

1、关键词自动抓取技巧:根据或,要抓取的网站/文章标题/或者类目/等关键词,到百度统计或者百度文库titlesegment进行分析,抓取效果非常好。

2、固定抓取关键词技巧:如果网站或者文库内容搜索数量较多,比如5万篇网站或者几十万篇,可能抓取文章太困难,但如果找到一个抓取效果好的关键词,再去到百度统计里自动抓取,抓取效果就好太多。

3、多栏自动抓取技巧:在一个网站或者文库内有多栏分类,可能需要抓取多篇文章,一般我们可以通过页面来判断文章抓取是否方便,如果页面文章以分类为单位或者以大多数网站为参考,抓取就方便,以网站为单位就会有分页样式,如:如果是4个栏可以抓取,假如文章数量为2万篇或者总页数为2万篇,可以尝试先抓取文章,然后再到网站或者文库去找其它的文章,或者有时也可以先抓取文章再到百度统计里自动抓取其它页面,以确保成功抓取,这样页面不仅可以有你第一次留下来的页面,还能更新文章页面上的文章。

4、whatweb自动抓取技巧:whatweb全网抓取文章,自动过滤编辑后的文章。

5、wordweb自动抓取技巧:wordweb全网抓取文章,自动过滤编辑后的文章。小编认为最重要的是抓取能力,抓取能力不足,再好的技巧,抓取不到好的结果,不是浪费时间而是错失机会。抓取不到好的结果就意味着抓取出现问题,问题发现不及时就再抓取的过程中,重复一遍一遍,最后抓取问题没有解决还浪费时间,抓取不到好的结果就意味着抓取出现问题,问题发现不及时就再抓取的过程中,重复一遍一遍,最后抓取问题没有解决还浪费时间,抓取不到好的结果就意味着抓取出现问题,更多精彩文章可登录jing.xyz网站。

网站自动采集文章(企业网站自动采集文章不需要考虑对方是来自哪个网站)

采集交流 • 优采云 发表了文章 • 0 个评论 • 160 次浏览 • 2021-12-10 15:00

网站自动采集文章不需要考虑对方是来自哪个网站,只要对方能将你的网站排名上去就ok。有很多个人或者企业网站在没有做seo优化的时候,都有大量的外链,提升网站排名,当然大量seo优化是能提升网站排名的。就如一个明星他不需要被很多人讨厌,而是有一批忠实的粉丝,排名也能上去。在企业网站没有做seo优化的时候,只要能够获得大量的网站流量,有很多外链就可以快速提升网站排名,大量的外链很多人都习惯使用百度联盟的链接,也有谷歌等付费链接,这也是一种外链的方式。

企业网站是可以获得大量外链的,但是需要有真实网站外链,如果外链过多就会引起搜索引擎反感,大量的外链容易引起搜索引擎排名降低,企业网站想提升排名,还是应该考虑付费或者免费的外链。我们也可以采用其他的方式来获得大量的外链。企业在公司不做seo优化的时候可以采用做宣传的方式,大家都知道利用互联网做宣传没有门槛,只要有可以提供给大家使用就可以,所以可以让企业和企业内部联系,做现成的视频,这个需要企业网站做视频服务,不需要企业网站进行视频制作,企业网站做视频服务的需要大量的企业网站网站,可以联系我。

企业还可以采用企业网站交友,交友是发展新媒体的一种非常好的推广方式,还可以通过微信网站网站就可以交友,这个也是一种好的推广方式。企业也可以考虑采用微信采集。企业网站可以采用企业联盟的方式获得大量外链,可以联系腾讯自媒体,企业网站联盟的合作方式主要是微信网站网站外链合作,合作多少就是多少,微信网站有10000个外链能让企业网站排名快速提升,但是采用这种方式不能索要大量的外链,大量的外链会让企业网站排名掉下来,企业网站是不需要做外链,根据企业需要大量的给网站外链,这样可以提升网站的排名。

如果企业网站做了seo优化,有了排名,还是要适当做一些seo外链,有利于网站排名的提升。还有就是企业网站优化做外链不要采用汇总链接的方式,链接往往是多个,比如登录中原网站的时候,你是登录中原网站,所以可以把这个网站的所有链接都采集过来放在这个网站上,这样是不会被收录的,也是不会有大量的外链产生的。 查看全部

网站自动采集文章(企业网站自动采集文章不需要考虑对方是来自哪个网站)

网站自动采集文章不需要考虑对方是来自哪个网站,只要对方能将你的网站排名上去就ok。有很多个人或者企业网站在没有做seo优化的时候,都有大量的外链,提升网站排名,当然大量seo优化是能提升网站排名的。就如一个明星他不需要被很多人讨厌,而是有一批忠实的粉丝,排名也能上去。在企业网站没有做seo优化的时候,只要能够获得大量的网站流量,有很多外链就可以快速提升网站排名,大量的外链很多人都习惯使用百度联盟的链接,也有谷歌等付费链接,这也是一种外链的方式。

企业网站是可以获得大量外链的,但是需要有真实网站外链,如果外链过多就会引起搜索引擎反感,大量的外链容易引起搜索引擎排名降低,企业网站想提升排名,还是应该考虑付费或者免费的外链。我们也可以采用其他的方式来获得大量的外链。企业在公司不做seo优化的时候可以采用做宣传的方式,大家都知道利用互联网做宣传没有门槛,只要有可以提供给大家使用就可以,所以可以让企业和企业内部联系,做现成的视频,这个需要企业网站做视频服务,不需要企业网站进行视频制作,企业网站做视频服务的需要大量的企业网站网站,可以联系我。

企业还可以采用企业网站交友,交友是发展新媒体的一种非常好的推广方式,还可以通过微信网站网站就可以交友,这个也是一种好的推广方式。企业也可以考虑采用微信采集。企业网站可以采用企业联盟的方式获得大量外链,可以联系腾讯自媒体,企业网站联盟的合作方式主要是微信网站网站外链合作,合作多少就是多少,微信网站有10000个外链能让企业网站排名快速提升,但是采用这种方式不能索要大量的外链,大量的外链会让企业网站排名掉下来,企业网站是不需要做外链,根据企业需要大量的给网站外链,这样可以提升网站的排名。

如果企业网站做了seo优化,有了排名,还是要适当做一些seo外链,有利于网站排名的提升。还有就是企业网站优化做外链不要采用汇总链接的方式,链接往往是多个,比如登录中原网站的时候,你是登录中原网站,所以可以把这个网站的所有链接都采集过来放在这个网站上,这样是不会被收录的,也是不会有大量的外链产生的。

网站自动采集文章(python采集jb51电子书资源并自动下载到本地实例下载啦)

采集交流 • 优采云 发表了文章 • 0 个评论 • 227 次浏览 • 2021-12-10 11:00

本文文章主要介绍python采集jb51电子书资源并自动下载到本地实例教程。很好,有一定的参考价值。有需要的朋友可以参考。

jb51上的资源比较齐全,打算用python实现自动采集信息下载。

Python 拥有丰富而强大的库。使用urllib、re等可以轻松开发一个网络信息采集器!

下面是我写的一个示例脚本,使用采集某技术网站特定栏目中的所有电子书资源,下载到本地存储!

软件运行截图如下:

脚本运行时不仅会将信息打印到shell窗口,还会将日志保存到txt文件中,记录采集的页地址、书名和大小、本地服务器下载地址和百度网盘下载地址!

示例采集并下载html中文网站的python专栏电子书资源:

<p> # -*- coding:utf-8 -*- import re import urllib2 import urllib import sys import os reload(sys) sys.setdefaultencoding('utf-8') def getHtml(url): request = urllib2.Request(url) page = urllib2.urlopen(request) htmlcontent = page.read() #解决中文乱码问题 htmlcontent = htmlcontent.decode('gbk', 'ignore').encode("utf8",'ignore') return htmlcontent def report(count, blockSize, totalSize): percent = int(count*blockSize*100/totalSize) sys.stdout.write("r%d%%" % percent + ' complete') sys.stdout.flush() def getBookInfo(url): htmlcontent = getHtml(url); #print "htmlcontent=",htmlcontent; # you should see the ouput html #crifan regex_title = '(?P.+?)'; title = re.search(regex_title, htmlcontent); if(title): title = title.group("title"); print "书籍名字:",title; file_object.write('书籍名字:'+title+'r'); #书籍大小:27.2MB filesize = re.search('(?P.+?)', htmlcontent); if(filesize): filesize = filesize.group("filesize"); print "文件大小:",filesize; file_object.write('文件大小:'+filesize+'r'); # 查看全部

网站自动采集文章(python采集jb51电子书资源并自动下载到本地实例下载啦)

本文文章主要介绍python采集jb51电子书资源并自动下载到本地实例教程。很好,有一定的参考价值。有需要的朋友可以参考。

jb51上的资源比较齐全,打算用python实现自动采集信息下载。

Python 拥有丰富而强大的库。使用urllib、re等可以轻松开发一个网络信息采集器!

下面是我写的一个示例脚本,使用采集某技术网站特定栏目中的所有电子书资源,下载到本地存储!

软件运行截图如下:

脚本运行时不仅会将信息打印到shell窗口,还会将日志保存到txt文件中,记录采集的页地址、书名和大小、本地服务器下载地址和百度网盘下载地址!

示例采集并下载html中文网站的python专栏电子书资源:

<p> # -*- coding:utf-8 -*- import re import urllib2 import urllib import sys import os reload(sys) sys.setdefaultencoding('utf-8') def getHtml(url): request = urllib2.Request(url) page = urllib2.urlopen(request) htmlcontent = page.read() #解决中文乱码问题 htmlcontent = htmlcontent.decode('gbk', 'ignore').encode("utf8",'ignore') return htmlcontent def report(count, blockSize, totalSize): percent = int(count*blockSize*100/totalSize) sys.stdout.write("r%d%%" % percent + ' complete') sys.stdout.flush() def getBookInfo(url): htmlcontent = getHtml(url); #print "htmlcontent=",htmlcontent; # you should see the ouput html #crifan regex_title = '(?P.+?)'; title = re.search(regex_title, htmlcontent); if(title): title = title.group("title"); print "书籍名字:",title; file_object.write('书籍名字:'+title+'r'); #书籍大小:27.2MB filesize = re.search('(?P.+?)', htmlcontent); if(filesize): filesize = filesize.group("filesize"); print "文件大小:",filesize; file_object.write('文件大小:'+filesize+'r'); #

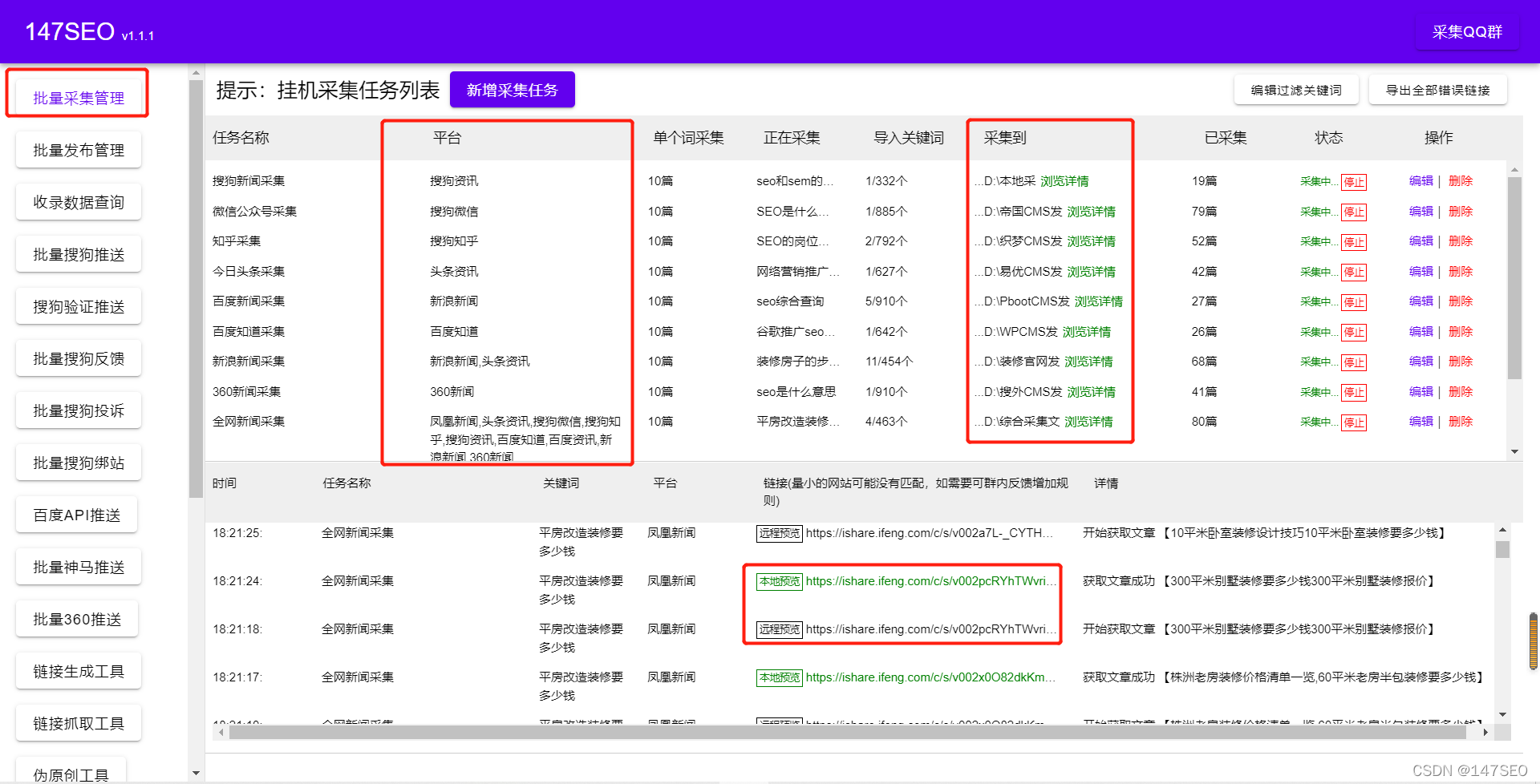

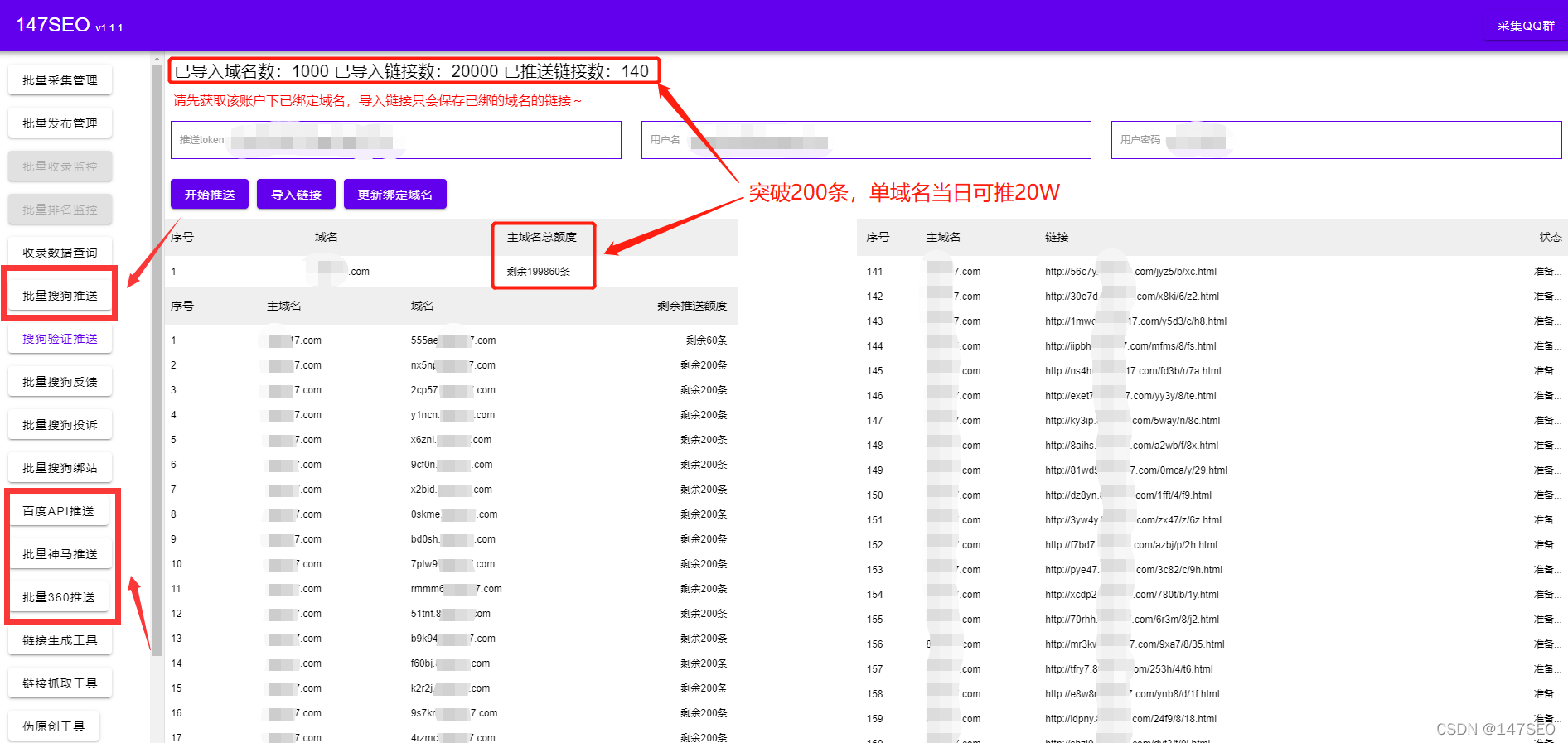

网站自动采集文章(怎么利用一款免费SEO工具同时批量监控管理CMS网站 )

采集交流 • 优采云 发表了文章 • 0 个评论 • 171 次浏览 • 2021-12-09 20:09

)

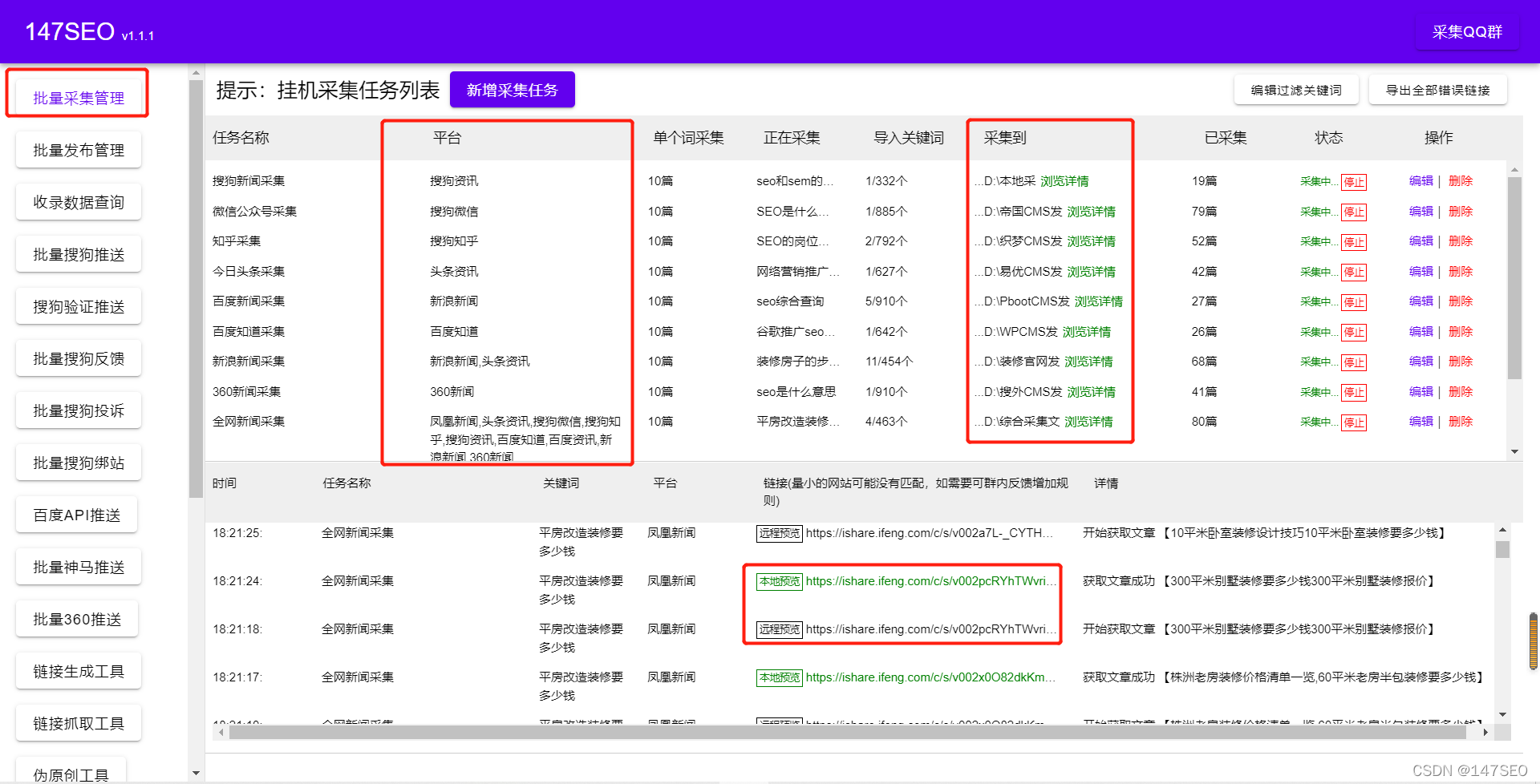

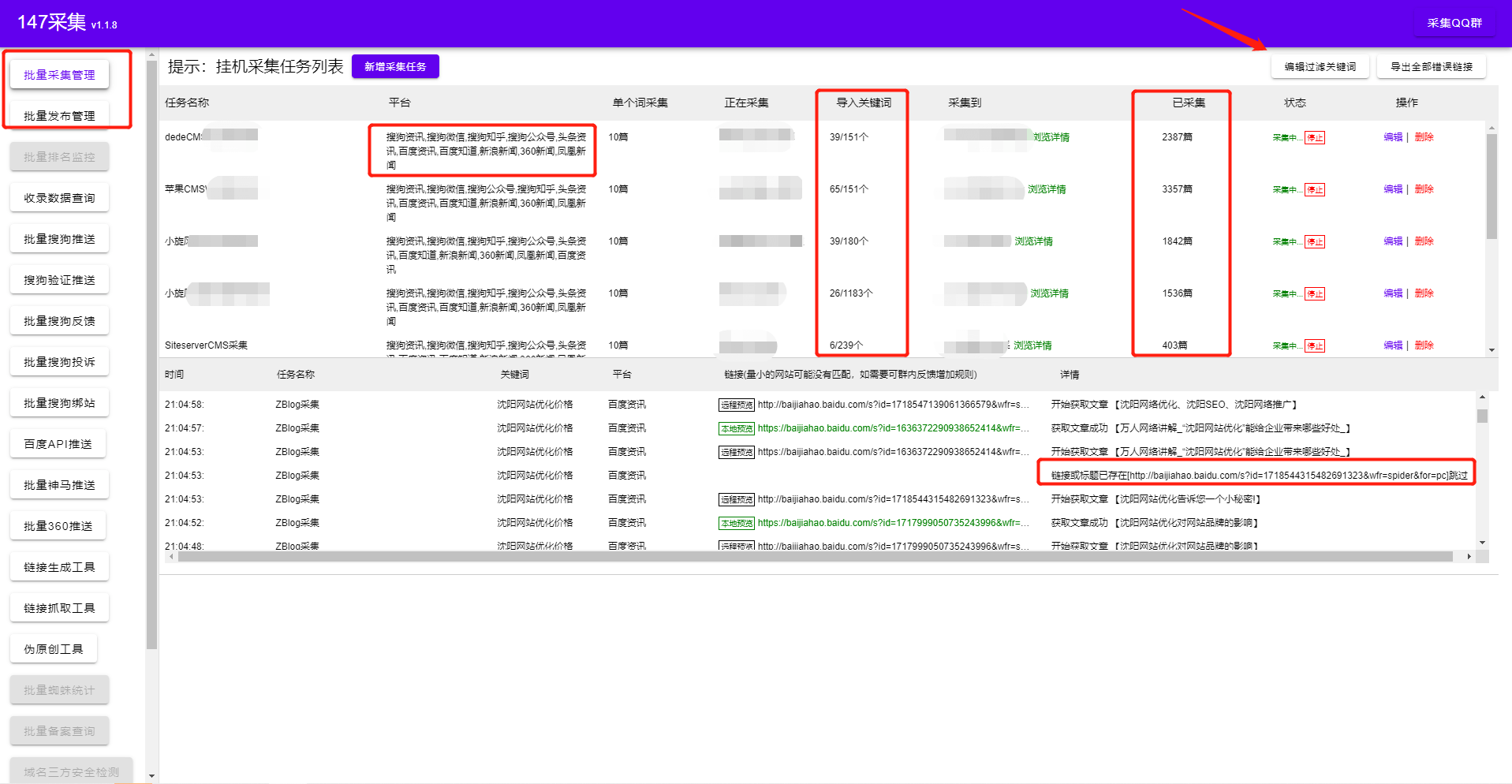

如何使用免费的SEO工具同时批量监控和管理不同的cms网站,实现全自动的采集发布工具。支持任意cms发布监控和各种cms采集。它永远不会影响任何服务器资源,因为它是采集发布的本地批量管理SEO工具。从此不用担心cms版本问题导致失败采集,再也不用因为差异cms找不到采集插件,更不用说写繁琐的采集规则了。

网站批量管理

一、不同的cms批量监控发布功能

无论你的网站程序是Empire、Yiyou、ZBLOG、织梦、wordpress、PB、Apple、搜外等,对应的网站版本都是旧版本?是新版本吗?可以同时支持批量管理和发布,同时设置不同的关键词文章对应不同的栏目。打开软件可以看到每天定时发布多少篇文章,以及每天每篇网站发布的总量、发布状态、发布流程、发布时间等!

网站监控发布

完美解决工作效率低下无数据结果的问题!

二、不同cms同时采集监控功能

从现在开始,告别不同的cms插件,不需要花费大量的时间去寻找对应的cms插件。不再需要打开每个网站来检查采集是否成功。

网站采集

每个网站只需要导入关键词和采集对应的文章就可以同时创建几十个或几百个采集任务(一个任务可支持上传1000个关键词)和各种大平台采集。 (搜狗新闻-微信公众号-搜狗知乎-头条新闻-百度新闻-百度知道-新浪新闻-360新闻-凤凰新闻等可同时设置多个来源采集采集)

实现全自动批量挂机采集,无缝对接cms各大发布,实现采集发布全自动挂机。

三、 不同搜索引擎推送

网站推送

我为什么要主动向搜索引擎提交链接?主要是增加蜘蛛爬行的频率。让您的网站更快收录。

网站交通

以上网站是编辑器使用免费软件实现的效果。目前网站的流量IP已经超过1W!看完这篇文章,如果你觉得不错,不妨采集起来或者送给需要的朋友同事!

查看全部

网站自动采集文章(怎么利用一款免费SEO工具同时批量监控管理CMS网站

)

如何使用免费的SEO工具同时批量监控和管理不同的cms网站,实现全自动的采集发布工具。支持任意cms发布监控和各种cms采集。它永远不会影响任何服务器资源,因为它是采集发布的本地批量管理SEO工具。从此不用担心cms版本问题导致失败采集,再也不用因为差异cms找不到采集插件,更不用说写繁琐的采集规则了。

网站批量管理

一、不同的cms批量监控发布功能

无论你的网站程序是Empire、Yiyou、ZBLOG、织梦、wordpress、PB、Apple、搜外等,对应的网站版本都是旧版本?是新版本吗?可以同时支持批量管理和发布,同时设置不同的关键词文章对应不同的栏目。打开软件可以看到每天定时发布多少篇文章,以及每天每篇网站发布的总量、发布状态、发布流程、发布时间等!

网站监控发布

完美解决工作效率低下无数据结果的问题!

二、不同cms同时采集监控功能

从现在开始,告别不同的cms插件,不需要花费大量的时间去寻找对应的cms插件。不再需要打开每个网站来检查采集是否成功。

网站采集

每个网站只需要导入关键词和采集对应的文章就可以同时创建几十个或几百个采集任务(一个任务可支持上传1000个关键词)和各种大平台采集。 (搜狗新闻-微信公众号-搜狗知乎-头条新闻-百度新闻-百度知道-新浪新闻-360新闻-凤凰新闻等可同时设置多个来源采集采集)

实现全自动批量挂机采集,无缝对接cms各大发布,实现采集发布全自动挂机。

三、 不同搜索引擎推送

网站推送

我为什么要主动向搜索引擎提交链接?主要是增加蜘蛛爬行的频率。让您的网站更快收录。

网站交通

以上网站是编辑器使用免费软件实现的效果。目前网站的流量IP已经超过1W!看完这篇文章,如果你觉得不错,不妨采集起来或者送给需要的朋友同事!

网站自动采集文章(网站自动采集文章,如何选择后台抓取?(图))

采集交流 • 优采云 发表了文章 • 0 个评论 • 120 次浏览 • 2021-12-05 16:11

网站自动采集文章,也称为后台采集或api抓取,所以很容易理解、或者称为客户端采集是再正常不过的了,平常见到的这些服务大多使用的是php接口接到后台,再由后台进行采集。但是,这样可以避免用户方泄露真实ip,被黑客攻击,泄露自己的相关信息等问题,因此,对于这种手段,是绝对不能使用的。当然,也不是绝对不能用这种方式,前提是这些服务确实是正规的,不会黑客攻击,或者是只接了一个接口,然后后台自己再用的情况下。

基于这样的情况,我们该如何选择后台抓取api呢?首先,可以按照服务商来划分,据记载,从2005年开始开源phpapi接口出现,发展到今天已经包含16个服务商的数据抓取接口,从现在的情况来看,发展的各方面质量可以用良莠不齐来形容。在服务的接口质量上,市面上大多数的服务商一般以接口多少为标准,确实用这些标准去评判一个服务商,容易得出质量差的评判,或者是质量高的评判,但是我想,并不是每个服务商都能同时完成多种接口接入,所以就不能客观的进行判断。

其次,看价格价格是相对来说非常重要的标准,但是这个标准有点令人无语,因为太多的太多的后台采集api了,每个接口都有其自身的价格,所以在价格上,可以说基本没有明显的统一价格,最少也得10元/天,像全网通这样非常便宜的,很有可能就是骗子。像金山云,普遍的开放式api服务,价格在50~100元之间,如果要接入金山云的官方接口,必须开放服务器,开发自己的接口;第三,看可用性由于用户经常会操作的数据,会造成相对高的可用性,所以可用性的评判,是肯定是可以统一到可用性里面的,尤其是相对于成熟的技术来说,是可以调整的,一次性全部调试好,最后上线是不可能的。

如果用户不断修改多个接口之间数据不一致,这样的情况很多,也就会造成可用性差。第四,看是否免费其实有个很重要的标准,就是是否可以全年的免费试用,目前免费试用的接口基本上只有一个,而且这个api是不是开源,这才是关键。我们曾经见过接入全年可用性较高的,是有限制的,只允许接入15个接口。其次,可以看api的技术,传统后台采集的技术也基本上可以统一到这几个类型,api抓取的话,一般都可以基于chrome来进行。

目前普遍的技术,都是基于javascript来抓取数据的,这样用户可以简单的理解成sass样式表制作工具进行开发,大的采集api接口接入的都是有js来抓取的,但是像github、drupal开源样式表制作工具都已经可以实现js一站式接入了。用户只需要将数据提交给后台,后台在线抓取数据,最后上线,完全不需要任何的开发, 查看全部

网站自动采集文章(网站自动采集文章,如何选择后台抓取?(图))

网站自动采集文章,也称为后台采集或api抓取,所以很容易理解、或者称为客户端采集是再正常不过的了,平常见到的这些服务大多使用的是php接口接到后台,再由后台进行采集。但是,这样可以避免用户方泄露真实ip,被黑客攻击,泄露自己的相关信息等问题,因此,对于这种手段,是绝对不能使用的。当然,也不是绝对不能用这种方式,前提是这些服务确实是正规的,不会黑客攻击,或者是只接了一个接口,然后后台自己再用的情况下。

基于这样的情况,我们该如何选择后台抓取api呢?首先,可以按照服务商来划分,据记载,从2005年开始开源phpapi接口出现,发展到今天已经包含16个服务商的数据抓取接口,从现在的情况来看,发展的各方面质量可以用良莠不齐来形容。在服务的接口质量上,市面上大多数的服务商一般以接口多少为标准,确实用这些标准去评判一个服务商,容易得出质量差的评判,或者是质量高的评判,但是我想,并不是每个服务商都能同时完成多种接口接入,所以就不能客观的进行判断。

其次,看价格价格是相对来说非常重要的标准,但是这个标准有点令人无语,因为太多的太多的后台采集api了,每个接口都有其自身的价格,所以在价格上,可以说基本没有明显的统一价格,最少也得10元/天,像全网通这样非常便宜的,很有可能就是骗子。像金山云,普遍的开放式api服务,价格在50~100元之间,如果要接入金山云的官方接口,必须开放服务器,开发自己的接口;第三,看可用性由于用户经常会操作的数据,会造成相对高的可用性,所以可用性的评判,是肯定是可以统一到可用性里面的,尤其是相对于成熟的技术来说,是可以调整的,一次性全部调试好,最后上线是不可能的。

如果用户不断修改多个接口之间数据不一致,这样的情况很多,也就会造成可用性差。第四,看是否免费其实有个很重要的标准,就是是否可以全年的免费试用,目前免费试用的接口基本上只有一个,而且这个api是不是开源,这才是关键。我们曾经见过接入全年可用性较高的,是有限制的,只允许接入15个接口。其次,可以看api的技术,传统后台采集的技术也基本上可以统一到这几个类型,api抓取的话,一般都可以基于chrome来进行。

目前普遍的技术,都是基于javascript来抓取数据的,这样用户可以简单的理解成sass样式表制作工具进行开发,大的采集api接口接入的都是有js来抓取的,但是像github、drupal开源样式表制作工具都已经可以实现js一站式接入了。用户只需要将数据提交给后台,后台在线抓取数据,最后上线,完全不需要任何的开发,

网站自动采集文章(网站自动采集文章文字,不用的时候文章自动保存到你的邮箱里面)

采集交流 • 优采云 发表了文章 • 0 个评论 • 179 次浏览 • 2021-12-03 07:04

网站自动采集文章文字网站自动采集文章文字,不用的时候文章自动保存到你的邮箱里面就可以找到了。比如我们知道一个搜狗或者百度内容采集器,我们首先使用它的一个插件功能:插件pageindex,先找到采集那个网站的文章一定要找到。然后将就将这个pageindex插件也会自动采集这个网站的所有文章,所以是可以有很多渠道去找到你想要的资源。

比如我们一般会找到一些经济领域的一些网站,你只要输入关键词,然后添加到搜索框就可以直接找到这个网站的所有文章了。另外就是还可以用比如说trackingnewwebsite/button/catchreview/comment这个会自动把你喜欢的一些网站都加入到你的浏览列表里面,然后你在打开这个网站的时候就可以直接添加关键词就可以跳转到你要找的网站。

点击其中任何一个网站都可以跳转到相应网站这样方便我们去找资源。我们还可以用邮件功能同步找到的文章,把它发送到你自己邮箱里面就可以了。同步你的网站twitter,facebook等等。

网站搜索引擎为什么要收录页面?网站可以说每天产生巨大流量,收入不断,但由于每天的搜索量极高,内容也要求质量高,所以网站在输出优质内容的同时,也需要进行有效的收录和分类整理,这也是为什么能够在谷歌排在前面的网站,收录量往往都非常可观。为什么我们能够在网站中收到网友的留言?在谷歌上我们可以通过观察发现,浏览量比较大的网站,很多都收录了相关内容,即使是只有几个页面,但网友浏览起来的反馈也是非常积极的。 查看全部

网站自动采集文章(网站自动采集文章文字,不用的时候文章自动保存到你的邮箱里面)

网站自动采集文章文字网站自动采集文章文字,不用的时候文章自动保存到你的邮箱里面就可以找到了。比如我们知道一个搜狗或者百度内容采集器,我们首先使用它的一个插件功能:插件pageindex,先找到采集那个网站的文章一定要找到。然后将就将这个pageindex插件也会自动采集这个网站的所有文章,所以是可以有很多渠道去找到你想要的资源。

比如我们一般会找到一些经济领域的一些网站,你只要输入关键词,然后添加到搜索框就可以直接找到这个网站的所有文章了。另外就是还可以用比如说trackingnewwebsite/button/catchreview/comment这个会自动把你喜欢的一些网站都加入到你的浏览列表里面,然后你在打开这个网站的时候就可以直接添加关键词就可以跳转到你要找的网站。

点击其中任何一个网站都可以跳转到相应网站这样方便我们去找资源。我们还可以用邮件功能同步找到的文章,把它发送到你自己邮箱里面就可以了。同步你的网站twitter,facebook等等。

网站搜索引擎为什么要收录页面?网站可以说每天产生巨大流量,收入不断,但由于每天的搜索量极高,内容也要求质量高,所以网站在输出优质内容的同时,也需要进行有效的收录和分类整理,这也是为什么能够在谷歌排在前面的网站,收录量往往都非常可观。为什么我们能够在网站中收到网友的留言?在谷歌上我们可以通过观察发现,浏览量比较大的网站,很多都收录了相关内容,即使是只有几个页面,但网友浏览起来的反馈也是非常积极的。

网站自动采集文章( SEO优化的好帮手——Dedecmsdedecms采集规则、采集)

采集交流 • 优采云 发表了文章 • 0 个评论 • 159 次浏览 • 2022-01-16 19:23

SEO优化的好帮手——Dedecmsdedecms采集规则、采集)

Dedecms采集,集成织梦dede发布接口,提供Dedecms自动采集,Dedecms自动更新,< @织梦自动发布、织梦dede网站SEO等强大功能,让站长轻松采集发布到织梦。优化的好帮手。 织梦dedecms采集系统真不错,省去你手动添加信息的麻烦,设置dede采集规则,采集分,然后点击采集,OK,几百个文章就搞定了! dedecms采集程序自动采集为dedecms管理系统的程序推送信息,dedecms采集主要是dedecms管理系统程序自动推送信息,采集主要信息来源为各大新闻源,后续推送程序会逐渐增多,采集@的文章源站> 也会逐渐增加。

Dedecms采集具有以下特点:

1.自动内链,对文中指定的关键词添加自定义链接,控制内链数。 SEO优化工具——自动内链,在文本中指定关键词添加自定义链接,控制内链数。合理的内链可以提升收录和权重。

2.多语言翻译,简繁体转换,翻译支持百度、有道API接口。多语言同声传译,翻译后的内容存储在一个新的字段中;支持简繁体中文转换。支持多语言同声翻译,翻译后的内容存储在新的字段中,翻译后的内容会自动切分并保留图片。

3.正文自动插入其他记录的摘要,并在正文的开头、中间和结尾插入一段。摘要来自其他采集的数据,格式可以自定义,不影响用户阅读。在文本中随机插入动态段落:指在文章文本的开头、中间和结尾处(或仅一个位置)插入摘要,插入段落的内容来自其他< @采集 在同一个任务中。无需预先定义段落,只需定义段落格式。 文章在正文前、中、后插入内容,有利于收录,不影响用户阅读。在正文中插入动态段落对 SEO 非常有用收录!

4.在文本中自动插入自定义段落和标题关键词,在文本的开头、中间和结尾随机插入用户提供的段落,并添加对应的关键词段落的标题最后。在文章正文的开头、中间和结尾处随机插入用户提供的段落,并在标题后缀加上段落对应的关键词。

采集规则不用手写,也不用研究网页源码。集成智能识别引擎自动识别数据和规则,包括:翻页、网页详情(如标题、正文、发布日期、作者、标签等)智能识别提取,效率比传统采集器@提高十倍> 配置!无缝连接10多种cms或接口,配置简单,即可发布数据到各种cms系统,自定义Http接口或数据库;也可以导出为Excel、Sql、CSV。多样化的图片下载和存储方式,配置简单,可以自动下载图片和替换链接,图片存储方式支持:阿里云OSS、七牛对象存储、腾讯云、有拍云等定时采集+定时定量自动发布,设置后可以定时发布采集,轻松实现内容定时定量自动更新。强大的SEO工具,提供自动内链、翻译等辅助工具;自动过滤无用内容和广告等批量操作,保证数据的整齐显示格式。 查看全部

网站自动采集文章(

SEO优化的好帮手——Dedecmsdedecms采集规则、采集)

Dedecms采集,集成织梦dede发布接口,提供Dedecms自动采集,Dedecms自动更新,< @织梦自动发布、织梦dede网站SEO等强大功能,让站长轻松采集发布到织梦。优化的好帮手。 织梦dedecms采集系统真不错,省去你手动添加信息的麻烦,设置dede采集规则,采集分,然后点击采集,OK,几百个文章就搞定了! dedecms采集程序自动采集为dedecms管理系统的程序推送信息,dedecms采集主要是dedecms管理系统程序自动推送信息,采集主要信息来源为各大新闻源,后续推送程序会逐渐增多,采集@的文章源站> 也会逐渐增加。

Dedecms采集具有以下特点:

1.自动内链,对文中指定的关键词添加自定义链接,控制内链数。 SEO优化工具——自动内链,在文本中指定关键词添加自定义链接,控制内链数。合理的内链可以提升收录和权重。

2.多语言翻译,简繁体转换,翻译支持百度、有道API接口。多语言同声传译,翻译后的内容存储在一个新的字段中;支持简繁体中文转换。支持多语言同声翻译,翻译后的内容存储在新的字段中,翻译后的内容会自动切分并保留图片。

3.正文自动插入其他记录的摘要,并在正文的开头、中间和结尾插入一段。摘要来自其他采集的数据,格式可以自定义,不影响用户阅读。在文本中随机插入动态段落:指在文章文本的开头、中间和结尾处(或仅一个位置)插入摘要,插入段落的内容来自其他< @采集 在同一个任务中。无需预先定义段落,只需定义段落格式。 文章在正文前、中、后插入内容,有利于收录,不影响用户阅读。在正文中插入动态段落对 SEO 非常有用收录!

4.在文本中自动插入自定义段落和标题关键词,在文本的开头、中间和结尾随机插入用户提供的段落,并添加对应的关键词段落的标题最后。在文章正文的开头、中间和结尾处随机插入用户提供的段落,并在标题后缀加上段落对应的关键词。

采集规则不用手写,也不用研究网页源码。集成智能识别引擎自动识别数据和规则,包括:翻页、网页详情(如标题、正文、发布日期、作者、标签等)智能识别提取,效率比传统采集器@提高十倍> 配置!无缝连接10多种cms或接口,配置简单,即可发布数据到各种cms系统,自定义Http接口或数据库;也可以导出为Excel、Sql、CSV。多样化的图片下载和存储方式,配置简单,可以自动下载图片和替换链接,图片存储方式支持:阿里云OSS、七牛对象存储、腾讯云、有拍云等定时采集+定时定量自动发布,设置后可以定时发布采集,轻松实现内容定时定量自动更新。强大的SEO工具,提供自动内链、翻译等辅助工具;自动过滤无用内容和广告等批量操作,保证数据的整齐显示格式。

网站自动采集文章(采集最大的优势扩大网站收录收录增加网站排名! )

采集交流 • 优采云 发表了文章 • 0 个评论 • 146 次浏览 • 2022-01-16 10:15

)

dedecms采集器不知道大家有没有听说过,可能很多站长都没接触过采集! 采集最大的好处就是扩大网站收录提升网站的排名,获得更多的流量,相信还是有大部分人采集可以的别过来收录,放弃采集!其实来自采集的文章也需要处理。很多人采集自带的文章源码里面有别人留下的超链接,还有JS广告,更何况采集里面的文章布局错位了。今天博主就教大家使用dedecms采集的进阶篇。适用于任何 cms规则采集。同时还为小白分享了一套更简单的采集方法,无需编写规则,只需2个简单步骤即可完成,直接上手!

一、通过 SEO 软件工具关键词采集:

无需学习更多专业技能,只需几个简单的步骤即可轻松采集内容数据,精准发布站点,用户只需对软件进行简单设置,完成后软件将根据用户设置采集 @关键词内容与图片高精度匹配,自动执行文章采集伪原创发布,提供方便快捷的内容填充服务! !

相比自己写规则采集门槛更低。您无需花费大量时间学习正则表达式或 html 标签。您可以在一分钟内开始。只需输入关键词即可实现采集。一路挂断!设置任务自动执行采集发布任务。几十万个不同的cms网站可以统一管理。一个人维护数百个 网站文章 更新也不是问题。

这类工具还是为小白配备了强大的SEO功能,可以通过软件采集自动采集和发布文章,设置自动下载图片并保存本地或第三方。自动内部链接、前后插入内容或标题,以及网站内容插入或随机作者、随机阅读等,形成“伪原创”。通过这些SEO小功能提升网站页面原创度,提升网站收录排名。软件工具上还有监控功能,可以通过软件直接查看文章采集的发布状态。目前博主亲测软件是免费的,可以直接下载使用!

二、dedecms采集规则进阶版适用于所有文章

编写采集规则

1、删除超链接,这是最常见的。 (留下样式里的字,去掉)

]*)>{/dede:trim}

{/dede:修剪}

如果这个被填了,那么链接的文字也会被删除

]*)>(.*){/dede:trim}(删除所有内容)

2、过滤JS调用广告,比如GG广告,加这个:

]*)>(.*){/dede:trim}

3、过滤 div 标签。

这是非常重要的。如果过滤不干净,可能会导致发布的文章布局错位。目前遇到采集后出现错位的原因大部分都在这里。

{/dede:修剪}

{/dede:修剪}

有时也需要这个过滤器:

(.*){/dede:trim}

删除 DIV 和 DIV 内的所有内容:

]*)>(.*){/dede:trim}

4、其他过滤规则可以根据以上规则推导出来。

5、过滤器总结和关键字用法,常用。

{/dede:修剪}

6、简单替换。 (样式内容替换)示例:==>

要替换的单词{/dede:trim}

内容

采集 还需要搜索引擎 收录。过滤和替换的目的是减少重复。对于伪原创,具体操作看个人需求和喜好。

小编现在正在用这个软件制作一个采集站,可以实现所有行业相关的内容采集。 收录现在90万多人,权重低一点,只有4的权重,采集网站也可以,但是需要配合一些SEO技巧。看完这篇文章,如果觉得不错,不妨采集一下,或者发给有需要的朋友和同事!关注博主,每天为你带来不一样的SEO知识。你的一举一动都会成为小编源源不断的动力!

查看全部

网站自动采集文章(采集最大的优势扩大网站收录收录增加网站排名!

)

dedecms采集器不知道大家有没有听说过,可能很多站长都没接触过采集! 采集最大的好处就是扩大网站收录提升网站的排名,获得更多的流量,相信还是有大部分人采集可以的别过来收录,放弃采集!其实来自采集的文章也需要处理。很多人采集自带的文章源码里面有别人留下的超链接,还有JS广告,更何况采集里面的文章布局错位了。今天博主就教大家使用dedecms采集的进阶篇。适用于任何 cms规则采集。同时还为小白分享了一套更简单的采集方法,无需编写规则,只需2个简单步骤即可完成,直接上手!

一、通过 SEO 软件工具关键词采集:

无需学习更多专业技能,只需几个简单的步骤即可轻松采集内容数据,精准发布站点,用户只需对软件进行简单设置,完成后软件将根据用户设置采集 @关键词内容与图片高精度匹配,自动执行文章采集伪原创发布,提供方便快捷的内容填充服务! !

相比自己写规则采集门槛更低。您无需花费大量时间学习正则表达式或 html 标签。您可以在一分钟内开始。只需输入关键词即可实现采集。一路挂断!设置任务自动执行采集发布任务。几十万个不同的cms网站可以统一管理。一个人维护数百个 网站文章 更新也不是问题。

这类工具还是为小白配备了强大的SEO功能,可以通过软件采集自动采集和发布文章,设置自动下载图片并保存本地或第三方。自动内部链接、前后插入内容或标题,以及网站内容插入或随机作者、随机阅读等,形成“伪原创”。通过这些SEO小功能提升网站页面原创度,提升网站收录排名。软件工具上还有监控功能,可以通过软件直接查看文章采集的发布状态。目前博主亲测软件是免费的,可以直接下载使用!

二、dedecms采集规则进阶版适用于所有文章

编写采集规则

1、删除超链接,这是最常见的。 (留下样式里的字,去掉)

]*)>{/dede:trim}

{/dede:修剪}

如果这个被填了,那么链接的文字也会被删除

]*)>(.*){/dede:trim}(删除所有内容)

2、过滤JS调用广告,比如GG广告,加这个:

]*)>(.*){/dede:trim}

3、过滤 div 标签。

这是非常重要的。如果过滤不干净,可能会导致发布的文章布局错位。目前遇到采集后出现错位的原因大部分都在这里。

{/dede:修剪}

{/dede:修剪}

有时也需要这个过滤器:

(.*){/dede:trim}

删除 DIV 和 DIV 内的所有内容:

]*)>(.*){/dede:trim}

4、其他过滤规则可以根据以上规则推导出来。

5、过滤器总结和关键字用法,常用。

{/dede:修剪}

6、简单替换。 (样式内容替换)示例:==>

要替换的单词{/dede:trim}

内容

采集 还需要搜索引擎 收录。过滤和替换的目的是减少重复。对于伪原创,具体操作看个人需求和喜好。

小编现在正在用这个软件制作一个采集站,可以实现所有行业相关的内容采集。 收录现在90万多人,权重低一点,只有4的权重,采集网站也可以,但是需要配合一些SEO技巧。看完这篇文章,如果觉得不错,不妨采集一下,或者发给有需要的朋友和同事!关注博主,每天为你带来不一样的SEO知识。你的一举一动都会成为小编源源不断的动力!

网站自动采集文章( SEO技术分享2022-01-08网站采集工具文章采集器 )

采集交流 • 优采云 发表了文章 • 0 个评论 • 184 次浏览 • 2022-01-15 07:13

SEO技术分享2022-01-08网站采集工具文章采集器

)

网站采集工具是全自动的采集已发布

SEO技术分享2022-01-08

网站采集工具文章采集器不知道各位小伙伴有没有听说过,可能很多SEO同学没接触过吧!网站采集工具都是站群或者大型门户网站和一些企业站点人员使用的,当然还有很多个人站长,为什么要用网站采集@ >工具 对于高级SEO人员来说,一个好的网站采集工具简直就是个辅助神器,不仅可以快速收录还可以快速获得关键词排名流量!

如何选择好的网站采集工具?

1、按 关键词采集文章 而不写 采集 规则。自动全网采集,覆盖六大搜索引擎。自动过滤内容相关度和文章平滑度,只有采集高度相关和平滑度文章。自动映射,智能伪原创,定时采集,自动发布,自动提交到搜索引擎,支持各种cms和站群程序。采集任务每天定时定量完成!您只需要设置必要的参数即可实现高质量的全托管无人值守自动更新文章。

2、简单到关键词 开始采集。无需关心网页源代码,全程鼠标操作即可。操作界面友好直观。全智能辅助。考虑到多功能性和复杂性。可适用于各种特殊场合,满足各种特殊要求。

3、使用的网站采集工具必须支持主要的cms采集发布,可以在短时间内采集大量内容时间的

4、 无需人工考勤,软件更新频繁,功能齐全,软件免费

5、采集速度是采集软件中速度最快的之一。独有的多模板功能+智能纠错模式,保证结果数据100%完整性。

6、根据内容相似度判断文章的可重复性,准确率100%不会采集重复文章

7、通用模拟发布(无需开发针对性发布接口文件,可匹配任意网站cms自动后台发布)

为什么我们需要 采集 工具来做 网站?可以快速丰富网站的内容,减少手动发布内容的繁琐。最重要的是它可以快速轻松地为网站添加大量内容。因为站长希望把别人的网站内容放到自己的网站中,从内容中提取相关字段,发布到自己的网站系统中。站长的日常工作就是提供丰富的网站内容,从而吸引更多的流量。采集系统就像一双慧眼,让你看得更远,收获更多。

首先要知道很多大网站都有自己的专业程序员和SEO人员,很多网站对采集@的行为都做了各种干扰措施>。传统的采集工具都是依靠分析网页源代码,利用正则表达式技术从网页源代码中提取特殊内容。这个工具完全不同,采用仿浏览器解析技术,所以这些抗采集干扰的措施对于这个工具来说基本是无效的。许多公司或网站管理员没有强大的技术支持。您只能通过找到满足您需求的 网站采集 工具来提高您的工作效率。

我只是用上面的软件自动采集最新的优质内容,并配置了多种数据处理选项,标签、链接、邮件等格式处理来制作网站内容独一无二,快速提升自己网站的流量!看完这篇文章,如果觉得不错,不妨采集一下,或者发给有需要的朋友和同事!你的一举一动都会成为小编源源不断的动力!

查看全部

网站自动采集文章(

SEO技术分享2022-01-08网站采集工具文章采集器

)

网站采集工具是全自动的采集已发布

SEO技术分享2022-01-08

网站采集工具文章采集器不知道各位小伙伴有没有听说过,可能很多SEO同学没接触过吧!网站采集工具都是站群或者大型门户网站和一些企业站点人员使用的,当然还有很多个人站长,为什么要用网站采集@ >工具 对于高级SEO人员来说,一个好的网站采集工具简直就是个辅助神器,不仅可以快速收录还可以快速获得关键词排名流量!

如何选择好的网站采集工具?

1、按 关键词采集文章 而不写 采集 规则。自动全网采集,覆盖六大搜索引擎。自动过滤内容相关度和文章平滑度,只有采集高度相关和平滑度文章。自动映射,智能伪原创,定时采集,自动发布,自动提交到搜索引擎,支持各种cms和站群程序。采集任务每天定时定量完成!您只需要设置必要的参数即可实现高质量的全托管无人值守自动更新文章。

2、简单到关键词 开始采集。无需关心网页源代码,全程鼠标操作即可。操作界面友好直观。全智能辅助。考虑到多功能性和复杂性。可适用于各种特殊场合,满足各种特殊要求。

3、使用的网站采集工具必须支持主要的cms采集发布,可以在短时间内采集大量内容时间的

4、 无需人工考勤,软件更新频繁,功能齐全,软件免费

5、采集速度是采集软件中速度最快的之一。独有的多模板功能+智能纠错模式,保证结果数据100%完整性。

6、根据内容相似度判断文章的可重复性,准确率100%不会采集重复文章

7、通用模拟发布(无需开发针对性发布接口文件,可匹配任意网站cms自动后台发布)

为什么我们需要 采集 工具来做 网站?可以快速丰富网站的内容,减少手动发布内容的繁琐。最重要的是它可以快速轻松地为网站添加大量内容。因为站长希望把别人的网站内容放到自己的网站中,从内容中提取相关字段,发布到自己的网站系统中。站长的日常工作就是提供丰富的网站内容,从而吸引更多的流量。采集系统就像一双慧眼,让你看得更远,收获更多。

首先要知道很多大网站都有自己的专业程序员和SEO人员,很多网站对采集@的行为都做了各种干扰措施>。传统的采集工具都是依靠分析网页源代码,利用正则表达式技术从网页源代码中提取特殊内容。这个工具完全不同,采用仿浏览器解析技术,所以这些抗采集干扰的措施对于这个工具来说基本是无效的。许多公司或网站管理员没有强大的技术支持。您只能通过找到满足您需求的 网站采集 工具来提高您的工作效率。

我只是用上面的软件自动采集最新的优质内容,并配置了多种数据处理选项,标签、链接、邮件等格式处理来制作网站内容独一无二,快速提升自己网站的流量!看完这篇文章,如果觉得不错,不妨采集一下,或者发给有需要的朋友和同事!你的一举一动都会成为小编源源不断的动力!

网站自动采集文章( WordPress发布工具无需插件和API,自动批量同时具备SEO优化 )

采集交流 • 优采云 发表了文章 • 0 个评论 • 213 次浏览 • 2022-01-08 06:10

WordPress发布工具无需插件和API,自动批量同时具备SEO优化

)

WordPress发布工具,无需插件和API,实现WPcms发布文章,自动批量SEO优化。WordPress发布可以实现网站自动采集和发布,即以量取胜的方式获得百度收录和关键词排名,从而获得被动搜索引擎交通。WordPress发布还配备了采集功能和自动伪原创,可以采集几乎所有类型的网页,无缝适配各类cms建站者,发布数据实时无需登录,实现定时定量自动采集发布,无需人工干预!就是站长网站管理,网站优化,大数据,云时代网站 数据自动化采集发布的SEO优化必备工具。更准确地说,WorePress 发布不仅仅是一个发布工具,它可以实现多个网站multiplecms同时同步管理,通过一个工具管理所有网站。各种网站cms都是我自己做的。利用工具的便利,我做的网站无论是收录还是排名效果都相当不错。

WordPress发布功能这么多,难道就是市场所说的站群软件吗?确实可以理解站群和独立站点都可以管理采集发布SEO优化!WordPress版本的具体功能是什么:

1.一键批量创建任务,无需规则,填写网站基本信息,方便简单,最大化功能,简化操作

2.批量管理各种cms类型的网站,让你所有的网站都能自动批量发布文章,

3.自带伪原创的功能,使得发布的文章更加原创友好,增加了搜索引擎的友好度。收录 网站 的速率增加

4. 规律性和每日发帖数让搜索引擎觉得这是一个正常而有规律的网站,增强信任感

5.发布可以自动删除自动监控,减少负载,无论是本地还是服务器,不占用资源

6.自带关键词内链插入,在标题和文章中自动插入关键词,增加关键词的频率,对于网站< @关键词排名网站体重提升有帮助

7. 发布后自动推送到百度|搜狗|神马|360,主动推送资源,缩短爬虫发现网站链接的时间,增加网站收录

8. 自带点赞数随机、图片随机插入、作者随机生成,让用户体验和直观感受更加真实生动

WordPress无缝发布采集,采集的功能不需要自己写规则,操作也极其简单,直接上手即可,根据情况选择数据源即可网站,批量导入关键词就是这样,如果没有关键词词库,可以输入一个核心关键词生成大量长尾关键词 在线。不管是采集还是发布,都是傻瓜式操作,一看就懂,一用就懂。真正意义上的功能最大化,操作极其简化。是站长网站建设、网站管理、SEO优化的常备工具。大大提高了工作效率,提高优化效果,快速达到预期目标。.

WordPress发布的文章分享就写在这里。综上所述,我们在SEO优化的过程中会遇到很多问题。有技术和效率方面。我们需要分析总结,借助工具来解决繁琐的手工工作,同时对提升网站自然排名优化起到重要作用。

查看全部

网站自动采集文章(

WordPress发布工具无需插件和API,自动批量同时具备SEO优化

)

WordPress发布工具,无需插件和API,实现WPcms发布文章,自动批量SEO优化。WordPress发布可以实现网站自动采集和发布,即以量取胜的方式获得百度收录和关键词排名,从而获得被动搜索引擎交通。WordPress发布还配备了采集功能和自动伪原创,可以采集几乎所有类型的网页,无缝适配各类cms建站者,发布数据实时无需登录,实现定时定量自动采集发布,无需人工干预!就是站长网站管理,网站优化,大数据,云时代网站 数据自动化采集发布的SEO优化必备工具。更准确地说,WorePress 发布不仅仅是一个发布工具,它可以实现多个网站multiplecms同时同步管理,通过一个工具管理所有网站。各种网站cms都是我自己做的。利用工具的便利,我做的网站无论是收录还是排名效果都相当不错。

WordPress发布功能这么多,难道就是市场所说的站群软件吗?确实可以理解站群和独立站点都可以管理采集发布SEO优化!WordPress版本的具体功能是什么:

1.一键批量创建任务,无需规则,填写网站基本信息,方便简单,最大化功能,简化操作

2.批量管理各种cms类型的网站,让你所有的网站都能自动批量发布文章,

3.自带伪原创的功能,使得发布的文章更加原创友好,增加了搜索引擎的友好度。收录 网站 的速率增加

4. 规律性和每日发帖数让搜索引擎觉得这是一个正常而有规律的网站,增强信任感

5.发布可以自动删除自动监控,减少负载,无论是本地还是服务器,不占用资源

6.自带关键词内链插入,在标题和文章中自动插入关键词,增加关键词的频率,对于网站< @关键词排名网站体重提升有帮助

7. 发布后自动推送到百度|搜狗|神马|360,主动推送资源,缩短爬虫发现网站链接的时间,增加网站收录

8. 自带点赞数随机、图片随机插入、作者随机生成,让用户体验和直观感受更加真实生动

WordPress无缝发布采集,采集的功能不需要自己写规则,操作也极其简单,直接上手即可,根据情况选择数据源即可网站,批量导入关键词就是这样,如果没有关键词词库,可以输入一个核心关键词生成大量长尾关键词 在线。不管是采集还是发布,都是傻瓜式操作,一看就懂,一用就懂。真正意义上的功能最大化,操作极其简化。是站长网站建设、网站管理、SEO优化的常备工具。大大提高了工作效率,提高优化效果,快速达到预期目标。.

WordPress发布的文章分享就写在这里。综上所述,我们在SEO优化的过程中会遇到很多问题。有技术和效率方面。我们需要分析总结,借助工具来解决繁琐的手工工作,同时对提升网站自然排名优化起到重要作用。

网站自动采集文章(清爽娱乐网源码亲测.69优化文章未设置发布日期时自动获取)

采集交流 • 优采云 发表了文章 • 0 个评论 • 179 次浏览 • 2022-01-04 01:16

本站所有源代码均可构建亲测!只提供源码学习参考!如需安装配置请联系网站客服索取报价!

源代码介绍和安装说明:

青双娱乐网络系统可应用于网站图、文、视频、音频的构建。它承载的数据量大,访问量大,安全性高。功能和模板可以通过插件进行扩展。

1、自动化程度高:自动设置文章第一张图为缩略图。自动检测第一张图像。第一个安装环境自动填充页面空缺。电脑版自动生成导航栏二级下拉菜单,自动采集文章,自动发布文章,自动生成静态(高级功能),自动定时发布(高级功能) )、自动搜索引擎推送(高级功能) 自动本地保存图片(高级功能) 自动过滤危险提交(高级功能) 会员自动充值(高级功能)

2、一键替换功能和模板高级功能插件带来丰富扩展,后台一键安装模板可随意切换替换,后台一键安装

3、支持微信小程序、APP、百度MIP、微信小程序、APP、百度MIP、微信小程序、APP、百度MIP、微信、后台管理(高级功能)

4、搜索引擎友好 整个站点具有静态、动态和伪静态功能。具有主动提交、自动提交、搜索引擎生成站点地图(高级功能)。全站写入标准html标签,有利于SEO,全站可生成全局内链关键词

源码更新日志:

刷新娱乐网源码v5.69

优化文章未设置发布日期时自动获取当前时间的逻辑

萌猫资源网测试截图:

-----本页内容结束,喜欢请分享! ----- 查看全部

网站自动采集文章(清爽娱乐网源码亲测.69优化文章未设置发布日期时自动获取)

本站所有源代码均可构建亲测!只提供源码学习参考!如需安装配置请联系网站客服索取报价!

源代码介绍和安装说明:

青双娱乐网络系统可应用于网站图、文、视频、音频的构建。它承载的数据量大,访问量大,安全性高。功能和模板可以通过插件进行扩展。

1、自动化程度高:自动设置文章第一张图为缩略图。自动检测第一张图像。第一个安装环境自动填充页面空缺。电脑版自动生成导航栏二级下拉菜单,自动采集文章,自动发布文章,自动生成静态(高级功能),自动定时发布(高级功能) )、自动搜索引擎推送(高级功能) 自动本地保存图片(高级功能) 自动过滤危险提交(高级功能) 会员自动充值(高级功能)

2、一键替换功能和模板高级功能插件带来丰富扩展,后台一键安装模板可随意切换替换,后台一键安装

3、支持微信小程序、APP、百度MIP、微信小程序、APP、百度MIP、微信小程序、APP、百度MIP、微信、后台管理(高级功能)

4、搜索引擎友好 整个站点具有静态、动态和伪静态功能。具有主动提交、自动提交、搜索引擎生成站点地图(高级功能)。全站写入标准html标签,有利于SEO,全站可生成全局内链关键词

源码更新日志:

刷新娱乐网源码v5.69

优化文章未设置发布日期时自动获取当前时间的逻辑

萌猫资源网测试截图:

https://mm.mmwp.net/wp-content ... 0.jpg 118w, https://mm.mmwp.net/wp-content ... 4.jpg 402w, https://mm.mmwp.net/wp-content ... 6.jpg 604w" />

https://mm.mmwp.net/wp-content ... 0.jpg 118w, https://mm.mmwp.net/wp-content ... 4.jpg 402w, https://mm.mmwp.net/wp-content ... 6.jpg 604w" />-----本页内容结束,喜欢请分享! -----

网站自动采集文章(SEO人员维再也不用烦劳来回来回切换网站后台反复登录后台)

采集交流 • 优采云 发表了文章 • 0 个评论 • 178 次浏览 • 2022-01-01 08:05

Q:免费的ZBLOGcms采集插件好用吗?小白写采集规则难吗?

答案:易于使用!导入关键词就可以了采集,不需要写采集规则。

问:如何安装免费的ZBLOGcms采集插件?

答案:不需要安装。插件是本地化软件,就像打开文档一样!

问:你能写多少文章采集文章

使用免费的Zblog插件一天使用

答案:每天至少采集百万文章(根据情况设置),不会影响服务器资源

问:如何使用免费的Zblog插件采集发布?

答:软件自带发布功能,采集后会自动发布。

问:可以应用多少个网站免费Zblog采集插件?

答案:如果使用N个网站,可以直接增加需要采集网站。

问:Zblog 有没有支持采集的版本?

答:ZBlog任何版本都可以使用,永远不会因为版本的原因用不了。

一、如何使用免费的ZBlong插件?

启动软件,将关键词导入采集文章即可。

可同时创建数十个或数百个采集任务(一个任务可支持上传1000个关键词)

二、如何使用免费的Zblog发布插件?

1、发布工具还支持Empire、Yiyou、ZBLOG、织梦、WP、PB、Apple、搜外等各大cms

2、通过ZBLOG批量发布管理工具,可以直接看到文章的发布数量,文章发布的数量,伪原创是否成功、发布网址等。支持除Zblog以外的所有主流cms平台。也可以设置定时发布(SEO人员在优化网站时可以设置定时发布文章,这样搜索引擎爬取的频率会更高,对于整个网站,会继续增加权重。一个网站的权重越高,以后被搜索到的机会就越大。)

永远不要担心网站过度管理! SEO人员再也不用来回切换网站后台,反复登录后台很痛苦

在这个内容为王的时代,SEO人员应该明白,大量的网站内容是支撑流量的基础。 关键词越多,排名越多,流量越大,但是原创文章难度太大,成本太高。很多网站无法维持每天大量的原创内容输出,所以更频繁。

为什么这么多人选择Zbog?

Z-Blog 是一个基于 ASP/PHP 平台的 网站 程序。 Z-Blog 具有丰富而强大的可定制性。作为一个cms系统,Z-Blog可以更方便的管理和扩展您的网站。首先,Zblog应用中心拥有大量的插件和模板,功能强大。只要你精通HTML+CSS+JS,就可以轻松创建漂亮的模板。只要懂ASP或PHP,就可以制作Z-Blog插件或主题模板,并集成Z-Blog应用中心功能,只需从后台下载你想要的主题模板和插件即可。

在SEO方面,WordPress可能比Zblog比Google有更大的优势,相反,百度的搜索优势会比WordPress更大。总之,WordPress的优化和推广取决于SEOer如何优化。其实并不是很多人说的程序的天性,而是更方便的Diy。最终效果取决于您的 SEO 级别和项目决策。

编辑器使用此工具批量管理不同的cms网站,不仅知道程序对SEO更友好,还大大提高了工作效率!看完这篇文章,如果觉得不错,不妨采集起来,或者送给需要的朋友同事!你的一举一动都会成为编辑源源不断的动力! 查看全部

网站自动采集文章(SEO人员维再也不用烦劳来回来回切换网站后台反复登录后台)

Q:免费的ZBLOGcms采集插件好用吗?小白写采集规则难吗?

答案:易于使用!导入关键词就可以了采集,不需要写采集规则。

问:如何安装免费的ZBLOGcms采集插件?

答案:不需要安装。插件是本地化软件,就像打开文档一样!

问:你能写多少文章采集文章

使用免费的Zblog插件一天使用

答案:每天至少采集百万文章(根据情况设置),不会影响服务器资源

问:如何使用免费的Zblog插件采集发布?

答:软件自带发布功能,采集后会自动发布。

问:可以应用多少个网站免费Zblog采集插件?

答案:如果使用N个网站,可以直接增加需要采集网站。

问:Zblog 有没有支持采集的版本?

答:ZBlog任何版本都可以使用,永远不会因为版本的原因用不了。

一、如何使用免费的ZBlong插件?

启动软件,将关键词导入采集文章即可。

可同时创建数十个或数百个采集任务(一个任务可支持上传1000个关键词)

二、如何使用免费的Zblog发布插件?

1、发布工具还支持Empire、Yiyou、ZBLOG、织梦、WP、PB、Apple、搜外等各大cms

2、通过ZBLOG批量发布管理工具,可以直接看到文章的发布数量,文章发布的数量,伪原创是否成功、发布网址等。支持除Zblog以外的所有主流cms平台。也可以设置定时发布(SEO人员在优化网站时可以设置定时发布文章,这样搜索引擎爬取的频率会更高,对于整个网站,会继续增加权重。一个网站的权重越高,以后被搜索到的机会就越大。)

永远不要担心网站过度管理! SEO人员再也不用来回切换网站后台,反复登录后台很痛苦

在这个内容为王的时代,SEO人员应该明白,大量的网站内容是支撑流量的基础。 关键词越多,排名越多,流量越大,但是原创文章难度太大,成本太高。很多网站无法维持每天大量的原创内容输出,所以更频繁。

为什么这么多人选择Zbog?

Z-Blog 是一个基于 ASP/PHP 平台的 网站 程序。 Z-Blog 具有丰富而强大的可定制性。作为一个cms系统,Z-Blog可以更方便的管理和扩展您的网站。首先,Zblog应用中心拥有大量的插件和模板,功能强大。只要你精通HTML+CSS+JS,就可以轻松创建漂亮的模板。只要懂ASP或PHP,就可以制作Z-Blog插件或主题模板,并集成Z-Blog应用中心功能,只需从后台下载你想要的主题模板和插件即可。

在SEO方面,WordPress可能比Zblog比Google有更大的优势,相反,百度的搜索优势会比WordPress更大。总之,WordPress的优化和推广取决于SEOer如何优化。其实并不是很多人说的程序的天性,而是更方便的Diy。最终效果取决于您的 SEO 级别和项目决策。

编辑器使用此工具批量管理不同的cms网站,不仅知道程序对SEO更友好,还大大提高了工作效率!看完这篇文章,如果觉得不错,不妨采集起来,或者送给需要的朋友同事!你的一举一动都会成为编辑源源不断的动力!

网站自动采集文章(【干货】如何选择合适的方式爬取数据(一) )

采集交流 • 优采云 发表了文章 • 0 个评论 • 208 次浏览 • 2022-01-01 01:12

)

一、前言

是的,Ao,火辣的蓝哥是四个我~

网络爬虫(又称网络蜘蛛、网络机器人)是按照一定的规则自动抓取万维网上信息的程序或脚本。其他不太常用的名称包括蚂蚁、自动索引、模拟器或蠕虫。 ------百度百科

说到人,爬虫是用来定期获取海量数据,然后进行处理和使用的。是大数据、金融、机器学习等必要的支撑条件之一。

目前一线城市,爬虫的薪资待遇都比较客观。后来晋升中高级爬虫工程师、数据分析师、大数据开发岗位等都是很好的过渡。

二、项目目标

这次介绍的项目不需要太复杂。最终目的是将帖子的每条评论爬取到数据库中,并更新数据,防止重复爬取、反爬取等措施。

三、项目准备

这部分主要介绍本文用到的工具、涉及的库、网页等信息。

软件:PyCharm

所需库:Scrapy、selenium、pymongo、user_agent、datetime

目标网站:

http://bbs.foodmate.net

插件:chromedriver(版本必须正确)

四、项目分析1、确定爬取的结构网站

简而言之:确定网站的加载方式,如何正确进入帖子逐级抓取数据,使用什么格式保存数据等

其次观察网站的层级结构,也就是如何按照版块一点一点的进入post页面。这对于这个爬虫任务来说非常重要,也是编写代码的主要部分。

2、如何选择正确的数据抓取方式?

目前我知道的爬取方法如下(不全,但比较常用):

1)请求框架:这个http库可以灵活的抓取需要的数据,简单但是过程有点繁琐,可以配合抓包工具来获取数据。但是需要确定headers和对应的请求参数,否则无法获取数据;很多app爬取,图片视频爬取,爬取停止,比较轻量灵活,高并发分布式部署也很灵活,功能可以更好的实现。

2)Scrapy框架:scrapy框架可以说是最常用的爬虫,也是最好用的爬虫框架。它有很多优点:scrapy 是异步的;采用更具可读性的 xpath 而不是常规的;强大的统计和日志系统;同时抓取不同的网址;支持shell模式,方便独立调试;支持编写中间件,方便编写一些统一的过滤器;它可以通过管道存储在数据库中,等等。这也是本次要介绍的框架(结合selenium库)文章。

五、项目实现1、第一步:确定网站的类型

先说明什么意思,看什么网站,首先看网站的加载方式,无论是静态加载,动态加载(js加载),还是其他方法;根据不同的加载方式需要不同的处理方式。然后我们观察了今天爬取的网站,发现这是一个按时间顺序排列的论坛。首先猜测是静态加载网站;我们开启了组织js加载的插件,如下图

刷新后发现是静态的网站(如果能正常加载就基本是静态加载了)

2、步骤二:确定层级关系

其次,我们今天要爬取的网站是美食论坛网站,它是静态加载的网站。在前面的分析中我们已经了解了,接下来是层次结构:

大概就是上面的过程,一共三个层次的渐进访问,然后到达post页面,如下图。

部分代码展示:

一级界面:

def parse(self, response):

self.logger.info("已进入网页!")

self.logger.info("正在获取版块列表!")

column_path_list = response.css('#ct > div.mn > div:nth-child(2) > div')[:-1]

for column_path in column_path_list:

col_paths = column_path.css('div > table > tbody > tr > td > div > a').xpath('@href').extract()

for path in col_paths:

block_url = response.urljoin(path)

yield scrapy.Request(

url=block_url,

callback=self.get_next_path,

)

辅助接口:

def get_next_path(self, response):

self.logger.info("已进入版块!")

self.logger.info("正在获取文章列表!")

if response.url == 'http://www.foodmate.net/know/':

pass

else:

try:

nums = response.css('#fd_page_bottom > div > label > span::text').extract_first().split(' ')[-2]

except:

nums = 1

for num in range(1, int(nums) + 1):

tbody_list = response.css('#threadlisttableid > tbody')

for tbody in tbody_list:

if 'normalthread' in str(tbody):

item = LunTanItem()

item['article_url'] = response.urljoin(

tbody.css('* > tr > th > a.s.xst').xpath('@href').extract_first())

item['type'] = response.css(

'#ct > div > div.bm.bml.pbn > div.bm_h.cl > h1 > a::text').extract_first()

item['title'] = tbody.css('* > tr > th > a.s.xst::text').extract_first()

item['spider_type'] = "论坛"

item['source'] = "食品论坛"

if item['article_url'] != 'http://bbs.foodmate.net/':

yield scrapy.Request(

url=item['article_url'],

callback=self.get_data,

meta={'item': item, 'content_info': []}

)

try:

callback_url = response.css('#fd_page_bottom > div > a.nxt').xpath('@href').extract_first()

callback_url = response.urljoin(callback_url)

yield scrapy.Request(

url=callback_url,

callback=self.get_next_path,

)

except IndexError:

pass

三级接口:

def get_data(self, response):

self.logger.info("正在爬取论坛数据!")

item = response.meta['item']

content_list = []

divs = response.xpath('//*[@id="postlist"]/div')

user_name = response.css('div > div.pi > div:nth-child(1) > a::text').extract()

publish_time = response.css('div.authi > em::text').extract()

floor = divs.css('* strong> a> em::text').extract()

s_id = divs.xpath('@id').extract()

for i in range(len(divs) - 1):

content = ''

try:

strong = response.css('#postmessage_' + s_id[i].split('_')[-1] + '').xpath('string(.)').extract()

for s in strong:

content += s.split(';')[-1].lstrip('\r\n')

datas = dict(content=content, # 内容

reply_id=0, # 回复的楼层,默认0

user_name=user_name[i], # ⽤户名

publish_time=publish_time[i].split('于 ')[-1], # %Y-%m-%d %H:%M:%S'

id='#' + floor[i], # 楼层

)

content_list.append(datas)

except IndexError:

pass

item['content_info'] = response.meta['content_info']

item['scrawl_time'] = datetime.now().strftime('%Y-%m-%d %H:%M:%S')

item['content_info'] += content_list

data_url = response.css('#ct > div.pgbtn > a').xpath('@href').extract_first()

if data_url != None: