网站程序自带的采集器采集文章

网站程序自带的采集器采集文章(拼多多的朋友想做竞品分析,找我帮忙用工具采集数据)

采集交流 • 优采云 发表了文章 • 0 个评论 • 216 次浏览 • 2021-11-24 08:01

不知道你有没有IT背景。如果没有,建议使用博威小邦软件机器人。数据采集是这个工具的基本功能之一。不需要IT背景,只需要基本的电脑操作,你懂的。采集 数据的目标软件、目标网页的登录、新增、复制粘贴等基本操作都可以。

采集 功能包括来自电脑端软件、网页采集表单数据、详情页字段、图片;可以设置各种条件采集,采集范围和时间采集,,采集完成输出你想要的Excel表格结构数据。

本软件主要是采集界面上的可见数据,包括一些网站限制复制粘贴数据。比如拼多多页面上的文字是不能用鼠标复制粘贴的。但是你可以用采集这个东西,只要显示在界面上,采集都不是问题。一个朋友在坑里想做竞品分析,求我帮忙用采集Data 这个工具是我叔推荐的软件机器人

像他们的电商行业的大企业一般都会使用各种专业的爬虫工具来获取数据进行分析和辅助营销决策,但是像我朋友这样的小企业一般没有那个投资预算和专业背景。因此,我向他推荐的数据工具“博威小邦软件机器人”配置相对简单。像他这样的电脑水平,完全IT外行,他可以轻松配置一个采集工具,采集拼多多,电商平台上所有可见的产品数据(价格、销量、规格) 、详细的文案、货架时间甚至买家评论等)

但我认为有一点陷阱。本工具不支持苹果系统,只能在Win7和Win10上运行。如果你的系统支持它,我建议你试试这个工具。 查看全部

网站程序自带的采集器采集文章(拼多多的朋友想做竞品分析,找我帮忙用工具采集数据)

不知道你有没有IT背景。如果没有,建议使用博威小邦软件机器人。数据采集是这个工具的基本功能之一。不需要IT背景,只需要基本的电脑操作,你懂的。采集 数据的目标软件、目标网页的登录、新增、复制粘贴等基本操作都可以。

采集 功能包括来自电脑端软件、网页采集表单数据、详情页字段、图片;可以设置各种条件采集,采集范围和时间采集,,采集完成输出你想要的Excel表格结构数据。

本软件主要是采集界面上的可见数据,包括一些网站限制复制粘贴数据。比如拼多多页面上的文字是不能用鼠标复制粘贴的。但是你可以用采集这个东西,只要显示在界面上,采集都不是问题。一个朋友在坑里想做竞品分析,求我帮忙用采集Data 这个工具是我叔推荐的软件机器人

像他们的电商行业的大企业一般都会使用各种专业的爬虫工具来获取数据进行分析和辅助营销决策,但是像我朋友这样的小企业一般没有那个投资预算和专业背景。因此,我向他推荐的数据工具“博威小邦软件机器人”配置相对简单。像他这样的电脑水平,完全IT外行,他可以轻松配置一个采集工具,采集拼多多,电商平台上所有可见的产品数据(价格、销量、规格) 、详细的文案、货架时间甚至买家评论等)

但我认为有一点陷阱。本工具不支持苹果系统,只能在Win7和Win10上运行。如果你的系统支持它,我建议你试试这个工具。

网站程序自带的采集器采集文章( 关于网页采集器的使用方法,以及我是如何通过本篇把网站做到权五的 )

采集交流 • 优采云 发表了文章 • 0 个评论 • 137 次浏览 • 2021-11-24 08:00

关于网页采集器的使用方法,以及我是如何通过本篇把网站做到权五的

)

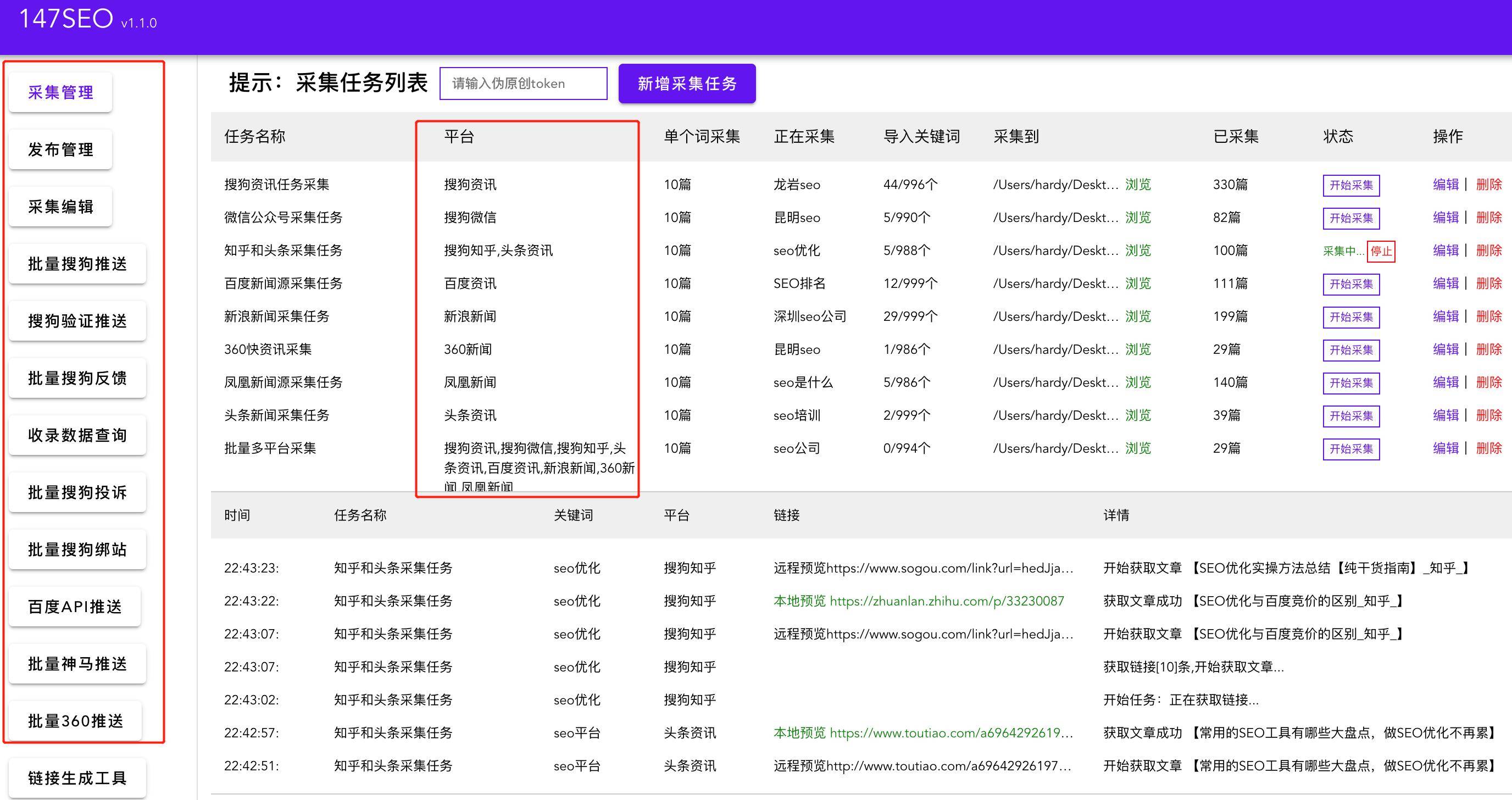

关于网页采集器的使用,以及我是如何使用采集器制作网站全武的。通过这篇文章,我将与大家分享采集器的一些使用技巧。看完你就会明白,把网站做到五点并不难!作为一个站长,我现在手头有将近一千个网站。我需要每天维护我的网站。最重要的是要填写网站的内容,手动肯定是做不到的。这个工作做完了,所以我总是用免费的采集器到文章采集,填上我自己的网站的内容。接下来给大家讲讲采集器怎么用好,以及一些增加网站权重的小方法。

首先,我告诉你为什么我们使用采集器 而不是自己创建网站 内容。目前,大多数站长和企业网站管理员需要不止一个网站日常维护,比如上万个域名。那么这么多网站的内容是哪里来的呢?你只能用采集的内容填写你自己的网站。

那我就告诉你一个采集器的选择。市场上有采集器几千万,大家都说好。小编总结为fit最好,必须满足以下几点:第一,成本问题,现在做站难,大部分站长都很难维护,小编认为免费是最好的!第二点是操作问题。毕竟大部分站长都不知道怎么写代码和采集规则,所以操作一定要非常简单,让一个什么都不知道的站长也能正常使用。第三点是实际问题。简单设置之后,最好挂断,不管什么样的,让他不停的接,不停的提供文章给网站。第四点,采集的来源一定要丰富。采集 的多平台资源非常重要。这样可以防止文章被同质化,也可以针对不同的搜索做。适用于收录。只要能同时满足这几点,就适合我们。小编一直通过免费采集器文章采集做到这一点,不仅可以满足日常网站 采集的数量需求,而且操作非常简单,简单配置后,放在那里挂断采集。

那我是怎么用采集来组成网站的呢?很多站长都说采集站大部分都是垃圾站。那是因为你根本没有做。很多人说采集站很容易被搜索引擎攻击。这就是为什么你不能这样做!说说我的方法吧。采集的来源肯定更多。比如百度,我会多一些采集一些标题文章。原因很简单。头条封杀了百度。头条蜘蛛,那么头条文章很可能百度没有收录,所以采集过去文章的内容质量会更好。第二点,采集一定要针对采集,比如你的网站是装修网,那么你的采集< @文章和标题一定要一致你对网站的定位,不想穿,在旅游网做装饰采集信息。第三点是采集中的文章必须处理,必须是伪原创!因为蜘蛛在爬取过程中会识别你的文章内容。如果重复率太高,就会判定你是采集网站的内容,抄袭别人的内容,所以得不到收录和排名。最后,新生成的文章链接一定要及时主动推送给搜索引擎,这样才能保证你的网站更多收录,也让搜索引擎知道你的更新频率!不想穿,在旅游网做装饰采集信息。第三点是采集中的文章必须处理,必须是伪原创!因为蜘蛛在爬取过程中会识别你的文章内容。如果重复率太高,就会判定你是采集网站的内容,抄袭别人的内容,所以得不到收录和排名。最后,新生成的文章链接一定要及时主动推送给搜索引擎,这样才能保证你的网站更多收录,也让搜索引擎知道你的更新频率!不想穿,在旅游网做装饰采集信息。第三点是采集中的文章必须处理,必须是伪原创!因为蜘蛛在爬取过程中会识别你的文章内容。如果重复率太高,就会判定你是采集网站的内容,抄袭别人的内容,所以得不到收录和排名。最后,新生成的文章链接一定要及时主动推送给搜索引擎,这样才能保证你的网站更多收录,也让搜索引擎知道你的更新频率!并且必须是 伪原创!因为蜘蛛在爬取过程中会识别你的文章内容。如果重复率太高,就会判定你是采集网站的内容,抄袭别人的内容,所以得不到收录和排名。最后,新生成的文章链接一定要及时主动推送给搜索引擎,这样才能保证你的网站更多收录,也让搜索引擎知道你的更新频率!并且必须是 伪原创!因为蜘蛛在爬取过程中会识别你的文章内容。如果重复率太高,就会判定你是采集网站的内容,抄袭别人的内容,所以得不到收录和排名。最后,新生成的文章链接一定要及时主动推送给搜索引擎,这样才能保证你的网站更多收录,也让搜索引擎知道你的更新频率!

其实想要网站做好,还有很多维度需要解决。今天小编主要讲和采集分享一些经验。做网站优化,我们必须考虑到每一个维度。编辑器可以做一个网站从零到五次方,不仅采集做得好,从一开始的域名服务器选择,再到后期的站点优化和异地优化,我研究点点滴滴,各方面都做好。我会陆续和大家分享更多的SEO相关知识。网站管理员可以喜欢、关注和添加到采集夹。同时也可以在评论区分享自己的一些SEO心得,让大家一起学习成长!

查看全部

网站程序自带的采集器采集文章(

关于网页采集器的使用方法,以及我是如何通过本篇把网站做到权五的

)

关于网页采集器的使用,以及我是如何使用采集器制作网站全武的。通过这篇文章,我将与大家分享采集器的一些使用技巧。看完你就会明白,把网站做到五点并不难!作为一个站长,我现在手头有将近一千个网站。我需要每天维护我的网站。最重要的是要填写网站的内容,手动肯定是做不到的。这个工作做完了,所以我总是用免费的采集器到文章采集,填上我自己的网站的内容。接下来给大家讲讲采集器怎么用好,以及一些增加网站权重的小方法。

首先,我告诉你为什么我们使用采集器 而不是自己创建网站 内容。目前,大多数站长和企业网站管理员需要不止一个网站日常维护,比如上万个域名。那么这么多网站的内容是哪里来的呢?你只能用采集的内容填写你自己的网站。

那我就告诉你一个采集器的选择。市场上有采集器几千万,大家都说好。小编总结为fit最好,必须满足以下几点:第一,成本问题,现在做站难,大部分站长都很难维护,小编认为免费是最好的!第二点是操作问题。毕竟大部分站长都不知道怎么写代码和采集规则,所以操作一定要非常简单,让一个什么都不知道的站长也能正常使用。第三点是实际问题。简单设置之后,最好挂断,不管什么样的,让他不停的接,不停的提供文章给网站。第四点,采集的来源一定要丰富。采集 的多平台资源非常重要。这样可以防止文章被同质化,也可以针对不同的搜索做。适用于收录。只要能同时满足这几点,就适合我们。小编一直通过免费采集器文章采集做到这一点,不仅可以满足日常网站 采集的数量需求,而且操作非常简单,简单配置后,放在那里挂断采集。

那我是怎么用采集来组成网站的呢?很多站长都说采集站大部分都是垃圾站。那是因为你根本没有做。很多人说采集站很容易被搜索引擎攻击。这就是为什么你不能这样做!说说我的方法吧。采集的来源肯定更多。比如百度,我会多一些采集一些标题文章。原因很简单。头条封杀了百度。头条蜘蛛,那么头条文章很可能百度没有收录,所以采集过去文章的内容质量会更好。第二点,采集一定要针对采集,比如你的网站是装修网,那么你的采集< @文章和标题一定要一致你对网站的定位,不想穿,在旅游网做装饰采集信息。第三点是采集中的文章必须处理,必须是伪原创!因为蜘蛛在爬取过程中会识别你的文章内容。如果重复率太高,就会判定你是采集网站的内容,抄袭别人的内容,所以得不到收录和排名。最后,新生成的文章链接一定要及时主动推送给搜索引擎,这样才能保证你的网站更多收录,也让搜索引擎知道你的更新频率!不想穿,在旅游网做装饰采集信息。第三点是采集中的文章必须处理,必须是伪原创!因为蜘蛛在爬取过程中会识别你的文章内容。如果重复率太高,就会判定你是采集网站的内容,抄袭别人的内容,所以得不到收录和排名。最后,新生成的文章链接一定要及时主动推送给搜索引擎,这样才能保证你的网站更多收录,也让搜索引擎知道你的更新频率!不想穿,在旅游网做装饰采集信息。第三点是采集中的文章必须处理,必须是伪原创!因为蜘蛛在爬取过程中会识别你的文章内容。如果重复率太高,就会判定你是采集网站的内容,抄袭别人的内容,所以得不到收录和排名。最后,新生成的文章链接一定要及时主动推送给搜索引擎,这样才能保证你的网站更多收录,也让搜索引擎知道你的更新频率!并且必须是 伪原创!因为蜘蛛在爬取过程中会识别你的文章内容。如果重复率太高,就会判定你是采集网站的内容,抄袭别人的内容,所以得不到收录和排名。最后,新生成的文章链接一定要及时主动推送给搜索引擎,这样才能保证你的网站更多收录,也让搜索引擎知道你的更新频率!并且必须是 伪原创!因为蜘蛛在爬取过程中会识别你的文章内容。如果重复率太高,就会判定你是采集网站的内容,抄袭别人的内容,所以得不到收录和排名。最后,新生成的文章链接一定要及时主动推送给搜索引擎,这样才能保证你的网站更多收录,也让搜索引擎知道你的更新频率!

其实想要网站做好,还有很多维度需要解决。今天小编主要讲和采集分享一些经验。做网站优化,我们必须考虑到每一个维度。编辑器可以做一个网站从零到五次方,不仅采集做得好,从一开始的域名服务器选择,再到后期的站点优化和异地优化,我研究点点滴滴,各方面都做好。我会陆续和大家分享更多的SEO相关知识。网站管理员可以喜欢、关注和添加到采集夹。同时也可以在评论区分享自己的一些SEO心得,让大家一起学习成长!

网站程序自带的采集器采集文章(优采云采集程序负责根据工作流对网页数据采集(组图))

采集交流 • 优采云 发表了文章 • 0 个评论 • 178 次浏览 • 2021-11-23 09:09

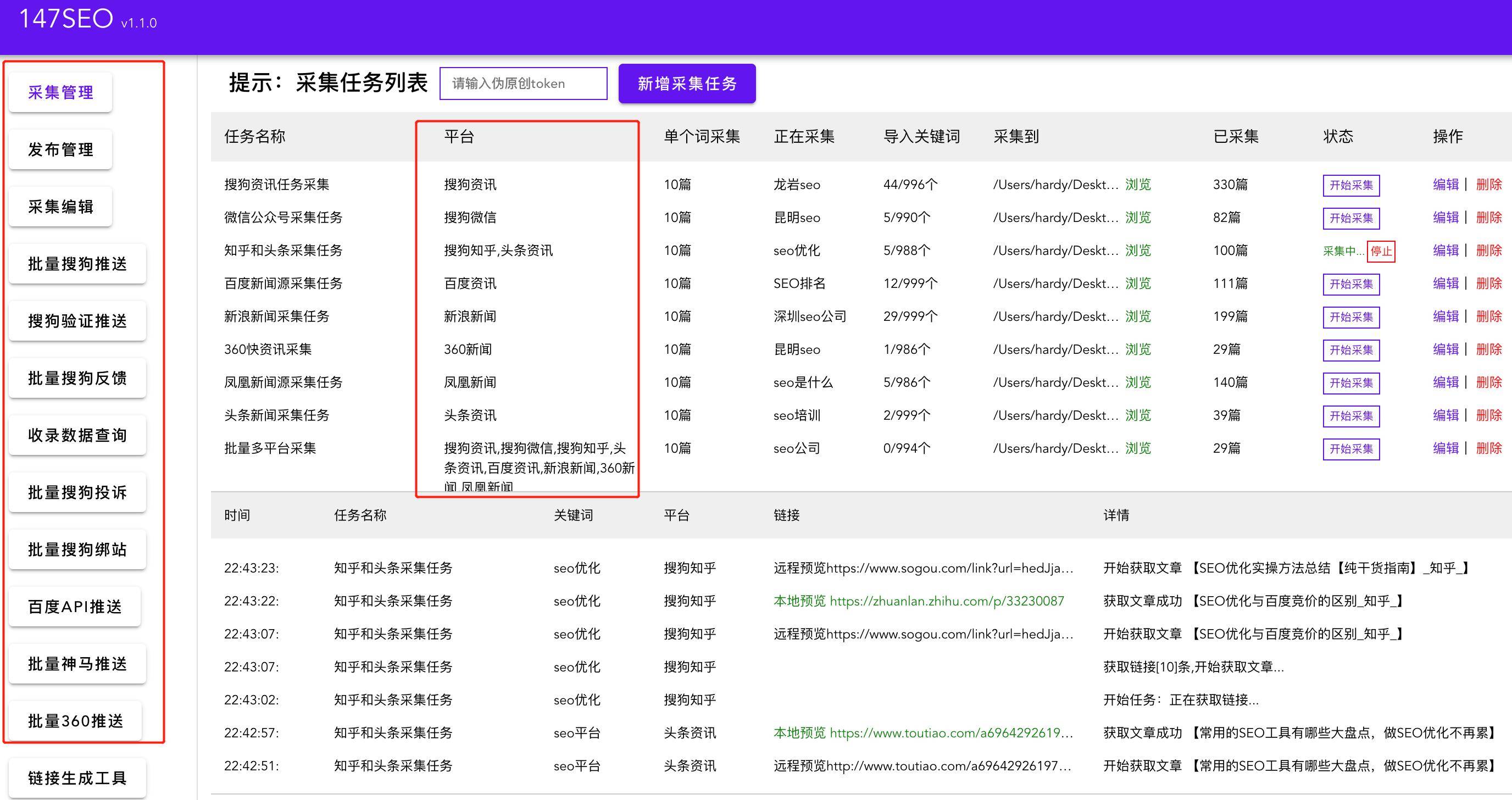

优采云采集 原理

优采云网页数据采集 客户端使用的开发语言是C#,运行在Windows上。客户端主程序负责任务配置与管理、任务云采集控制、云集成数据管理(导出、清理、发布)。数据导出程序负责将数据导出为Excel、SQL、TXT、MYSQL等,支持一次导出百万条数据。本地采集程序负责根据工作流打开和抓取网页,采集数据用于通过正则表达式和Xpath原理快速获取网页数据。

整个采集流程基于Firefox内核浏览器,通过模拟人的思维操作(如打开网页、点击网页中的按钮)自动提取网页内容。系统将过程操作完全可视化,无需专业知识,轻松实现数据采集。通过准确定位网页源代码中每条数据的XPath路径,优采云可以准确的采集批量输出用户需要的数据。

优采云实现的功能

优采云网页数据采集 系统基于完全自主研发的分布式云计算平台。它可以在短时间内轻松地从各种网站或网页中获取大量数据。标准化数据,帮助任何需要从网页获取信息的客户实现数据自动化采集、编辑、标准化,摆脱对人工搜索和数据采集的依赖,从而降低获取信息的成本,提高效率。涉及政府、高校、企业、银行、电子商务、科研、汽车、房地产、媒体等多个行业和领域。

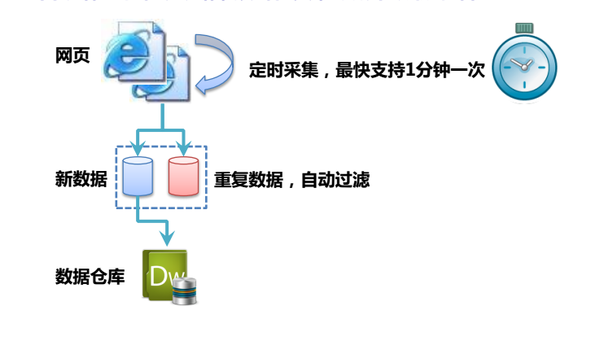

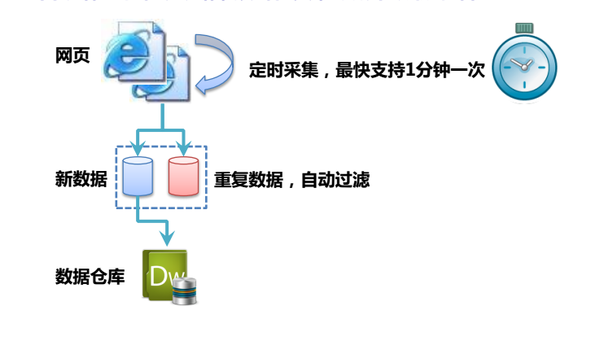

图1:采集示意图

优采云作为一般的网页数据采集器,并不是针对某个网站某个行业的数据采集,而是在网页上可以看到或者几乎所有的网页源码中的文字信息可以是采集,市面上98%的网页都可以使用优采云来表示采集。

使用本地采集(单机采集),除了抓取大部分网页数据外,还可以在采集过程中进行初步的数据清洗。如果使用程序自带的正则工具,请使用正则表达式来格式化数据。可以在数据源实现去除空格、过滤日期等各种操作。其次,优采云还提供了分支判断功能,可以对网页中的信息是否正确进行逻辑判断,从而达到用户筛选需求。

除了本地采集(单机采集)的所有功能外,云端采集还可以实现定时采集、实时监控、自动重复数据删除和存储,并增加采集的数量,验证码自动识别,API接口多样化,导出数据和修改参数。同时,使用云端并发运行多个节点,采集的速度会比本地的采集(单机采集)快很多,并且自动切换任务启动时的多个IP也可以避免网站 IP块,实现采集比较完整的数据。

图 2:时序云采集 查看全部

网站程序自带的采集器采集文章(优采云采集程序负责根据工作流对网页数据采集(组图))

优采云采集 原理

优采云网页数据采集 客户端使用的开发语言是C#,运行在Windows上。客户端主程序负责任务配置与管理、任务云采集控制、云集成数据管理(导出、清理、发布)。数据导出程序负责将数据导出为Excel、SQL、TXT、MYSQL等,支持一次导出百万条数据。本地采集程序负责根据工作流打开和抓取网页,采集数据用于通过正则表达式和Xpath原理快速获取网页数据。

整个采集流程基于Firefox内核浏览器,通过模拟人的思维操作(如打开网页、点击网页中的按钮)自动提取网页内容。系统将过程操作完全可视化,无需专业知识,轻松实现数据采集。通过准确定位网页源代码中每条数据的XPath路径,优采云可以准确的采集批量输出用户需要的数据。

优采云实现的功能

优采云网页数据采集 系统基于完全自主研发的分布式云计算平台。它可以在短时间内轻松地从各种网站或网页中获取大量数据。标准化数据,帮助任何需要从网页获取信息的客户实现数据自动化采集、编辑、标准化,摆脱对人工搜索和数据采集的依赖,从而降低获取信息的成本,提高效率。涉及政府、高校、企业、银行、电子商务、科研、汽车、房地产、媒体等多个行业和领域。

图1:采集示意图

优采云作为一般的网页数据采集器,并不是针对某个网站某个行业的数据采集,而是在网页上可以看到或者几乎所有的网页源码中的文字信息可以是采集,市面上98%的网页都可以使用优采云来表示采集。

使用本地采集(单机采集),除了抓取大部分网页数据外,还可以在采集过程中进行初步的数据清洗。如果使用程序自带的正则工具,请使用正则表达式来格式化数据。可以在数据源实现去除空格、过滤日期等各种操作。其次,优采云还提供了分支判断功能,可以对网页中的信息是否正确进行逻辑判断,从而达到用户筛选需求。

除了本地采集(单机采集)的所有功能外,云端采集还可以实现定时采集、实时监控、自动重复数据删除和存储,并增加采集的数量,验证码自动识别,API接口多样化,导出数据和修改参数。同时,使用云端并发运行多个节点,采集的速度会比本地的采集(单机采集)快很多,并且自动切换任务启动时的多个IP也可以避免网站 IP块,实现采集比较完整的数据。

图 2:时序云采集

网站程序自带的采集器采集文章( 关于网页采集器的使用方法,以及我是如何通过本篇把网站做到权五的 )

采集交流 • 优采云 发表了文章 • 0 个评论 • 153 次浏览 • 2021-11-23 09:09

关于网页采集器的使用方法,以及我是如何通过本篇把网站做到权五的

)

关于如何使用采集器网页,以及我如何使用采集器制作网站全舞。通过这篇文章,我将与大家分享采集器的一些使用技巧。看完你就会明白,把网站做到五点并不难!作为一个站长,我现在手头有将近一千个网站。我需要每天维护我的网站。最重要的是要填写网站的内容,手动肯定是做不到的。这个工作做完了,所以我总是用免费的采集器到文章采集,填上我自己的网站的内容。接下来说一下采集器怎么用好,以及一些增加网站权重的小方法。

关于如何使用采集器网页,以及我如何使用采集器制作网站全舞。通过这篇文章,我将与大家分享采集器的一些使用技巧。看完你就会明白,把网站做到五点并不难!作为一个站长,我现在手头有将近一千个网站。我需要每天维护我的网站。最重要的是要填写网站的内容,手动肯定是做不到的。这个工作做完了,所以我总是用免费的采集器到文章采集,填上我自己的网站的内容。接下来说一下采集器怎么用好,以及一些增加网站权重的小方法。

首先,我告诉你为什么我们使用采集器 而不是自己创建网站 内容。目前,大多数站长和企业网站管理员需要不止一个网站日常维护,比如上万个域名。那么这么多网站的内容是哪里来的呢?你只能用采集的内容填写你自己的网站。

那我就告诉你一个采集器的选择。市场上有采集器几千万,大家都说好。小编总结为fit最好,必须满足以下几点:第一,成本问题,现在做站难,大部分站长都很难维护,小编认为免费是最好的!第二点是操作问题。毕竟大部分站长都不知道怎么写代码和采集规则,所以操作一定要非常简单,让一个什么都不知道的站长也能正常使用。第三点是实际问题。简单设置之后,最好挂断,不管什么样的,让他不停的接,不停的提供文章给网站。第四点,采集的来源一定要丰富。采集 的多平台资源非常重要。这样可以防止文章被同质化。它也可以用于不同的搜索。适用于收录。只要能同时满足这几点,就适合我们。编辑一直通过免费采集器文章采集来做,不仅可以满足日常网站 采集数量需求,而且操作非常简单. 简单配置后,放在那里挂断采集。采集,不仅可以满足日常网站 采集的数量需求,而且操作非常简单。简单配置后,放在那里挂断采集。采集,不仅可以满足日常网站 采集的数量需求,而且操作非常简单。简单配置后,放在那里挂断采集。

那我是怎么用采集来组成网站的呢?很多站长都说采集站大部分都是垃圾站。那是因为你根本没有做。很多人说采集站很容易被搜索引擎攻击。这就是为什么你不能这样做!说说我的方法吧。采集的来源肯定更多。以百度为例,我会多一些采集一些标题文章。原因很简单。头条封杀百度。头条蜘蛛,那么头条文章很有可能百度没有收录,所以采集过去文章的优质内容会更好。第二点,采集一定要针对采集,比如你的网站是装修网,那么你的采集文章 而且标题一定要符合你的网站定位,不想穿,做装饰采集旅游资讯。第三点是采集中的文章必须被处理,而且必须是伪原创!因为蜘蛛在爬取过程中会识别出你的文章的内容,如果重复次数太高,会判断你是采集的站点,复制别人的内容,这样你就可以't get 收录 和排名。最后,新生成的文章链接一定要及时主动推送给搜索引擎,这样才能保证你的网站更多收录,也让搜索引擎知道你的一 更新频率!第三点是采集中的文章必须被处理,而且必须是伪原创!因为蜘蛛在爬取过程中会识别出你的文章的内容,如果重复次数太高,会判断你是采集的站点,复制别人的内容,这样你就可以't get 收录 和排名。最后,新生成的文章链接一定要及时主动推送给搜索引擎,这样才能保证你的网站更多收录,也让搜索引擎知道你的一 更新频率!第三点是采集中的文章必须被处理,而且必须是伪原创!因为蜘蛛在爬取过程中会识别出你的文章的内容,如果重复次数太高,会判断你是采集的站点,复制别人的内容,这样你就可以't get 收录 和排名。最后,新生成的文章链接一定要及时主动推送给搜索引擎,这样才能保证你的网站更多收录,也让搜索引擎知道你的一 更新频率!复制别人的内容,这样你就得不到收录和排名。最后,新生成的文章链接一定要及时主动推送给搜索引擎,这样才能保证你的网站更多收录,也让搜索引擎知道你的一 更新频率!复制别人的内容,这样你就得不到收录和排名。最后,新生成的文章链接一定要及时主动推送给搜索引擎,这样才能保证你的网站更多收录,也让搜索引擎知道你的一 更新频率!

其实想要网站做好,还有很多维度需要解决。今天小编主要讲和采集分享一些经验。做网站优化,我们必须考虑到每一个维度。编辑器可以做一个网站从零到五次方,不仅采集做得好,从一开始的域名服务器选择,再到后期的站点优化和异地优化,我研究把每一点都学好,各方面都做好。我会陆续和大家分享更多的SEO相关知识。网站管理员可以喜欢、关注和添加到采集夹。同时,大家可以在评论区分享自己的一些SEO心得,大家一起学习成长!

查看全部

网站程序自带的采集器采集文章(

关于网页采集器的使用方法,以及我是如何通过本篇把网站做到权五的

)

关于如何使用采集器网页,以及我如何使用采集器制作网站全舞。通过这篇文章,我将与大家分享采集器的一些使用技巧。看完你就会明白,把网站做到五点并不难!作为一个站长,我现在手头有将近一千个网站。我需要每天维护我的网站。最重要的是要填写网站的内容,手动肯定是做不到的。这个工作做完了,所以我总是用免费的采集器到文章采集,填上我自己的网站的内容。接下来说一下采集器怎么用好,以及一些增加网站权重的小方法。

关于如何使用采集器网页,以及我如何使用采集器制作网站全舞。通过这篇文章,我将与大家分享采集器的一些使用技巧。看完你就会明白,把网站做到五点并不难!作为一个站长,我现在手头有将近一千个网站。我需要每天维护我的网站。最重要的是要填写网站的内容,手动肯定是做不到的。这个工作做完了,所以我总是用免费的采集器到文章采集,填上我自己的网站的内容。接下来说一下采集器怎么用好,以及一些增加网站权重的小方法。

首先,我告诉你为什么我们使用采集器 而不是自己创建网站 内容。目前,大多数站长和企业网站管理员需要不止一个网站日常维护,比如上万个域名。那么这么多网站的内容是哪里来的呢?你只能用采集的内容填写你自己的网站。

那我就告诉你一个采集器的选择。市场上有采集器几千万,大家都说好。小编总结为fit最好,必须满足以下几点:第一,成本问题,现在做站难,大部分站长都很难维护,小编认为免费是最好的!第二点是操作问题。毕竟大部分站长都不知道怎么写代码和采集规则,所以操作一定要非常简单,让一个什么都不知道的站长也能正常使用。第三点是实际问题。简单设置之后,最好挂断,不管什么样的,让他不停的接,不停的提供文章给网站。第四点,采集的来源一定要丰富。采集 的多平台资源非常重要。这样可以防止文章被同质化。它也可以用于不同的搜索。适用于收录。只要能同时满足这几点,就适合我们。编辑一直通过免费采集器文章采集来做,不仅可以满足日常网站 采集数量需求,而且操作非常简单. 简单配置后,放在那里挂断采集。采集,不仅可以满足日常网站 采集的数量需求,而且操作非常简单。简单配置后,放在那里挂断采集。采集,不仅可以满足日常网站 采集的数量需求,而且操作非常简单。简单配置后,放在那里挂断采集。

那我是怎么用采集来组成网站的呢?很多站长都说采集站大部分都是垃圾站。那是因为你根本没有做。很多人说采集站很容易被搜索引擎攻击。这就是为什么你不能这样做!说说我的方法吧。采集的来源肯定更多。以百度为例,我会多一些采集一些标题文章。原因很简单。头条封杀百度。头条蜘蛛,那么头条文章很有可能百度没有收录,所以采集过去文章的优质内容会更好。第二点,采集一定要针对采集,比如你的网站是装修网,那么你的采集文章 而且标题一定要符合你的网站定位,不想穿,做装饰采集旅游资讯。第三点是采集中的文章必须被处理,而且必须是伪原创!因为蜘蛛在爬取过程中会识别出你的文章的内容,如果重复次数太高,会判断你是采集的站点,复制别人的内容,这样你就可以't get 收录 和排名。最后,新生成的文章链接一定要及时主动推送给搜索引擎,这样才能保证你的网站更多收录,也让搜索引擎知道你的一 更新频率!第三点是采集中的文章必须被处理,而且必须是伪原创!因为蜘蛛在爬取过程中会识别出你的文章的内容,如果重复次数太高,会判断你是采集的站点,复制别人的内容,这样你就可以't get 收录 和排名。最后,新生成的文章链接一定要及时主动推送给搜索引擎,这样才能保证你的网站更多收录,也让搜索引擎知道你的一 更新频率!第三点是采集中的文章必须被处理,而且必须是伪原创!因为蜘蛛在爬取过程中会识别出你的文章的内容,如果重复次数太高,会判断你是采集的站点,复制别人的内容,这样你就可以't get 收录 和排名。最后,新生成的文章链接一定要及时主动推送给搜索引擎,这样才能保证你的网站更多收录,也让搜索引擎知道你的一 更新频率!复制别人的内容,这样你就得不到收录和排名。最后,新生成的文章链接一定要及时主动推送给搜索引擎,这样才能保证你的网站更多收录,也让搜索引擎知道你的一 更新频率!复制别人的内容,这样你就得不到收录和排名。最后,新生成的文章链接一定要及时主动推送给搜索引擎,这样才能保证你的网站更多收录,也让搜索引擎知道你的一 更新频率!

其实想要网站做好,还有很多维度需要解决。今天小编主要讲和采集分享一些经验。做网站优化,我们必须考虑到每一个维度。编辑器可以做一个网站从零到五次方,不仅采集做得好,从一开始的域名服务器选择,再到后期的站点优化和异地优化,我研究把每一点都学好,各方面都做好。我会陆续和大家分享更多的SEO相关知识。网站管理员可以喜欢、关注和添加到采集夹。同时,大家可以在评论区分享自己的一些SEO心得,大家一起学习成长!

网站程序自带的采集器采集文章(深网是网络的一部分,与浅网(surfaceWeb)对立)

采集交流 • 优采云 发表了文章 • 0 个评论 • 168 次浏览 • 2021-11-20 07:07

在上一篇文章中,我们意识到一个网站从一个链接随机跳转到另一个链接。但是,如果需要将整个网站按类别系统地归类,或者搜索网站上的每一页,则必须采集整个网站,这非常在消耗内存资源的过程,尤其是处理大的网站时,最合适的工具是使用数据库来存储采集的资源。

1. 深网和暗网

您可能听说过诸如深网、暗网或隐藏网之类的术语,尤其是在最近的媒体中。他们的意思是什么?深网是网的一部分,与表网相反。浅层网络是网络中可以被互联网上的搜索引擎捕获的部分。据不完全统计,大约90%的互联网实际上是一个深网。因为谷歌不能做表单提交之类的事情,也不能找到没有直接链接到顶级域名的网页,或者因为robots.txt禁止而无法查看网站,所以数浅网比较深。还是比较少的。

暗网,也称为暗网或暗网,完全是另一种“怪物”。它们也是建立在现有网络的基础上,但使用 Tor 客户端,在 HTTP 之上运行一个新协议,并为信息交换提供安全隧道。这样的暗网也可以是采集,就像你的采集其他网站,不过这些内容超出了本章的范围。

与暗网不同,深网相对容易采集。它可以让你采集那些谷歌爬虫机器人无法获取的深层网络信息。

2.遍历整个网站网络数据采集有很多好处:

(1)生成网站地图

使用爬虫采集整个网站,采集所有的链接,然后将所有的页面组织成网站的实际形式。

(2)采集数据

创建专业垂直搜索平台,想采集一些文章(博客、新闻、故事等)。虽然这些网站采集并不费劲,但是需要爬虫有足够的深度(我们打算有网站的猴子应急数据不多)。所以创建一个爬虫来递归遍历每个网站,只采集那些网站页面上的数据。一种常见且耗时的网站采集方法是从首页(如首页)开始,然后搜索页面上的所有链接,形成一个列表。然后去这些链接的每一页采集,然后将每一页找到的链接组成一个新的列表,重复下一轮采集。

显然,这是一种复杂性迅速增长的情况。如果每个页面有10个链接,而网站上有5个页面深度(中等规模的主流深度),那么如果你想要采集整个网站,一共采集 的网页数量为 10^5,即 100,000 页。不过,虽然“5页深度,每页10个链接”是网站的主流配置,但实际上,真正拥有10万个以上页面的网站却寥寥无几。这是因为大部分链是重复的。

为了防止一个页面被采集两次,去除重复链接非常重要。代码运行时,将所有找到的链接放在一起,保存在一个方便查询的列表中(下面的例子指的是Python的set类型)。只有新链接会采集,然后从页面搜索其他链接。

from urllib.request import urlopen

from bs4 import BeautifulSoup

import re

pages=set()

def getLinks(pageUrl):

global pages

html=urlopen("https://en.wikipedia.org"+pageUrl)

bsObj=BeautifulSoup(html,"html.parser")

for link in bsObj.findAll("a",href=re.compile("^(/wiki/)")):

if 'href' in link.attrs:

if link.attrs["href"] not in pages:

print(newPage)

newPage=link.attrs["href"]

pages.add(newPage)

getLinks(newPage)

getLinks("")

为了充分展示这个网络数据 采集 示例的工作原理,我删除了“只查找内部链接”标准。不再限制爬虫采集的页面范围,只要遇到一个页面,就会查找所有以/wiki/开头的链接,无论链接是否收录分号。

一开始用getLinks处理一个空的URL,其实就是维基百科的首页,因为空的URL在函数中。然后遍历首页的每个链接,查看是否已经在全局变量pages集合中。如果不是,则将其打印到屏幕并添加到页面集合中,然后使用 getLinks 递归处理该链接。这里需要注意的一点是python的默认递归限制是1000次,当达到递归限制时程序会自动停止。

3. 采集整个 网站 数据

当然,如果你只是从一个页面跳转到另一个页面,那么网络爬虫是很无聊的。为了有效地使用它们,我们需要在使用爬虫时在页面上做一些事情。让我们看看如何创建一个爬虫来采集页面标题、正文的第一段和编辑页面的链接(如果有的话)。

和往常一样,决定如何做这些事情的第一步是观察网站上的一些页面,然后绘制一个采集模式。通过观察几个维基百科页面,包括条目页面和非术语页面,例如隐私政策页面,您将获得以下规则:

(1)所有的标题(在所有页面上,无论是入口页面、编辑历史页面还是其他页面)都在h1-span标签中,页面上只有一个h1标签;

(前面提到2),所有的正文文本都在div#bodyContent标签中。但是,如果我们想进一步获取第一段文本,我们可能使用div#mw-contet-text->p更好(仅选择第一段的标签。此规则适用于所有页面,除了文件页面,它不收录部分内容文本(内容文本)

(3)编辑链接只出现在入口页面,如果有编辑链接,都在li#ca-edit->span->a。

完整的程序代码如下:

from urllib.request import urlopen

from bs4 import BeautifulSoup

import re

pages=set()

def getLinks(pageUrl):

global pages

html=urlopen("https://en.wikipedia.org"+pageUrl)

bsObj=BeautifulSoup(html,"html.parser")

try:

print(bsObj.h1.get_text())

print(bsObj.find(id="mw-content-text").findAll("p")[0])

print(bsObj.find(id="ca-edit").find("span").find("a").attrs['href'])

except AttributeError:

print("页面缺少一些属性,Don't worry")

for link in bsObj.findAll("a",href=re.compile("^(/wiki/)")):

if 'href' in link.attrs:

if link.attrs["href"] not in pages:

print("---------\n"+newPage)

newPage=link.attrs["href"]

pages.add(newPage)

getLinks(newPage)

getLinks("")

因为我们不可能保证每一页上都有所有类型的数据,所以每个打印语句都是按照数据出现在页面上的概率降序排列的。换句话说,标题标签会出现在每一页上,所以我们首先尝试获取它的数据。正文内容会出现在大多数页面(文件页面除外),所以它是第二个获取的数据。“编辑”按钮只出现在获取了标题和正文内容的页面上,并不是所有页面都有,所以放在最后。 查看全部

网站程序自带的采集器采集文章(深网是网络的一部分,与浅网(surfaceWeb)对立)

在上一篇文章中,我们意识到一个网站从一个链接随机跳转到另一个链接。但是,如果需要将整个网站按类别系统地归类,或者搜索网站上的每一页,则必须采集整个网站,这非常在消耗内存资源的过程,尤其是处理大的网站时,最合适的工具是使用数据库来存储采集的资源。

1. 深网和暗网

您可能听说过诸如深网、暗网或隐藏网之类的术语,尤其是在最近的媒体中。他们的意思是什么?深网是网的一部分,与表网相反。浅层网络是网络中可以被互联网上的搜索引擎捕获的部分。据不完全统计,大约90%的互联网实际上是一个深网。因为谷歌不能做表单提交之类的事情,也不能找到没有直接链接到顶级域名的网页,或者因为robots.txt禁止而无法查看网站,所以数浅网比较深。还是比较少的。

暗网,也称为暗网或暗网,完全是另一种“怪物”。它们也是建立在现有网络的基础上,但使用 Tor 客户端,在 HTTP 之上运行一个新协议,并为信息交换提供安全隧道。这样的暗网也可以是采集,就像你的采集其他网站,不过这些内容超出了本章的范围。

与暗网不同,深网相对容易采集。它可以让你采集那些谷歌爬虫机器人无法获取的深层网络信息。

2.遍历整个网站网络数据采集有很多好处:

(1)生成网站地图

使用爬虫采集整个网站,采集所有的链接,然后将所有的页面组织成网站的实际形式。

(2)采集数据

创建专业垂直搜索平台,想采集一些文章(博客、新闻、故事等)。虽然这些网站采集并不费劲,但是需要爬虫有足够的深度(我们打算有网站的猴子应急数据不多)。所以创建一个爬虫来递归遍历每个网站,只采集那些网站页面上的数据。一种常见且耗时的网站采集方法是从首页(如首页)开始,然后搜索页面上的所有链接,形成一个列表。然后去这些链接的每一页采集,然后将每一页找到的链接组成一个新的列表,重复下一轮采集。

显然,这是一种复杂性迅速增长的情况。如果每个页面有10个链接,而网站上有5个页面深度(中等规模的主流深度),那么如果你想要采集整个网站,一共采集 的网页数量为 10^5,即 100,000 页。不过,虽然“5页深度,每页10个链接”是网站的主流配置,但实际上,真正拥有10万个以上页面的网站却寥寥无几。这是因为大部分链是重复的。

为了防止一个页面被采集两次,去除重复链接非常重要。代码运行时,将所有找到的链接放在一起,保存在一个方便查询的列表中(下面的例子指的是Python的set类型)。只有新链接会采集,然后从页面搜索其他链接。

from urllib.request import urlopen

from bs4 import BeautifulSoup

import re

pages=set()

def getLinks(pageUrl):

global pages

html=urlopen("https://en.wikipedia.org"+pageUrl)

bsObj=BeautifulSoup(html,"html.parser")

for link in bsObj.findAll("a",href=re.compile("^(/wiki/)")):

if 'href' in link.attrs:

if link.attrs["href"] not in pages:

print(newPage)

newPage=link.attrs["href"]

pages.add(newPage)

getLinks(newPage)

getLinks("")

为了充分展示这个网络数据 采集 示例的工作原理,我删除了“只查找内部链接”标准。不再限制爬虫采集的页面范围,只要遇到一个页面,就会查找所有以/wiki/开头的链接,无论链接是否收录分号。

一开始用getLinks处理一个空的URL,其实就是维基百科的首页,因为空的URL在函数中。然后遍历首页的每个链接,查看是否已经在全局变量pages集合中。如果不是,则将其打印到屏幕并添加到页面集合中,然后使用 getLinks 递归处理该链接。这里需要注意的一点是python的默认递归限制是1000次,当达到递归限制时程序会自动停止。

3. 采集整个 网站 数据

当然,如果你只是从一个页面跳转到另一个页面,那么网络爬虫是很无聊的。为了有效地使用它们,我们需要在使用爬虫时在页面上做一些事情。让我们看看如何创建一个爬虫来采集页面标题、正文的第一段和编辑页面的链接(如果有的话)。

和往常一样,决定如何做这些事情的第一步是观察网站上的一些页面,然后绘制一个采集模式。通过观察几个维基百科页面,包括条目页面和非术语页面,例如隐私政策页面,您将获得以下规则:

(1)所有的标题(在所有页面上,无论是入口页面、编辑历史页面还是其他页面)都在h1-span标签中,页面上只有一个h1标签;

(前面提到2),所有的正文文本都在div#bodyContent标签中。但是,如果我们想进一步获取第一段文本,我们可能使用div#mw-contet-text->p更好(仅选择第一段的标签。此规则适用于所有页面,除了文件页面,它不收录部分内容文本(内容文本)

(3)编辑链接只出现在入口页面,如果有编辑链接,都在li#ca-edit->span->a。

完整的程序代码如下:

from urllib.request import urlopen

from bs4 import BeautifulSoup

import re

pages=set()

def getLinks(pageUrl):

global pages

html=urlopen("https://en.wikipedia.org"+pageUrl)

bsObj=BeautifulSoup(html,"html.parser")

try:

print(bsObj.h1.get_text())

print(bsObj.find(id="mw-content-text").findAll("p")[0])

print(bsObj.find(id="ca-edit").find("span").find("a").attrs['href'])

except AttributeError:

print("页面缺少一些属性,Don't worry")

for link in bsObj.findAll("a",href=re.compile("^(/wiki/)")):

if 'href' in link.attrs:

if link.attrs["href"] not in pages:

print("---------\n"+newPage)

newPage=link.attrs["href"]

pages.add(newPage)

getLinks(newPage)

getLinks("")

因为我们不可能保证每一页上都有所有类型的数据,所以每个打印语句都是按照数据出现在页面上的概率降序排列的。换句话说,标题标签会出现在每一页上,所以我们首先尝试获取它的数据。正文内容会出现在大多数页面(文件页面除外),所以它是第二个获取的数据。“编辑”按钮只出现在获取了标题和正文内容的页面上,并不是所有页面都有,所以放在最后。

网站程序自带的采集器采集文章(如何采集58同城上面信息?58商家采集软件)

采集交流 • 优采云 发表了文章 • 0 个评论 • 118 次浏览 • 2021-11-20 05:11

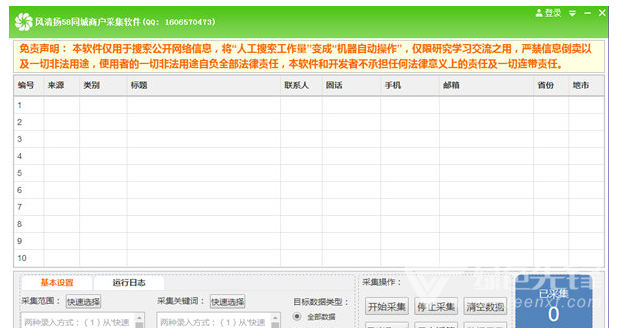

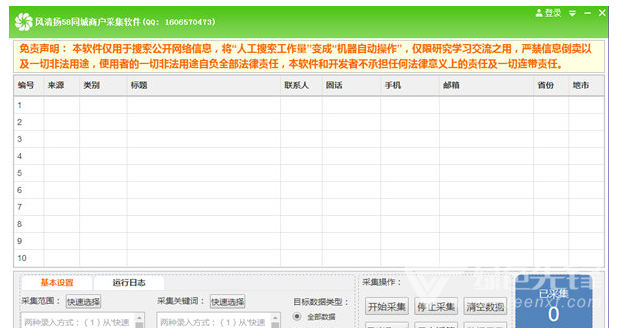

风清阳58城商采集软件(58城采集器)是专为58城商开发的最新搜索软件。如何采集58同城信息?风清阳58城商务采集软件(58城采集器)轻松帮助用户。以相关行业网站为数据源,足以获取同城各渠道商户信息采集。您可以选择网站、选择城市、选择行业分类等条件搜索您需要的数据。属性包括“来源网站、类别、职位、联系人、联系方式、省、城市、发布日期”等等。

软件优势:

1、支持系统:

Win7 及以上(32 位或 64 位均可)。XP不支持。

2、数据量:

整个软件数据量超过500万,数据由相关网站不定期更新。我们的软件本身不会更新任何数据。

3、准确度:

我们无法保证行业的准确性。我们只能保证数据来自相关的网站。我们无法保证数据的质量。如需了解数据质量,可直接登录相关网站了解。

4、试用版和正版的区别:

试用版有采集导出密钥信息加密(24小时限时试用),没有其他限制,购买前可以试用。

5、采集速度:

没有任何限制,具体取决于您的机器性能和带宽。

特征:

傻瓜式操作,鼠标点选,无需写任何采集规则,【可直接导出Excel文件,一键导入手机通讯录,适合微信营销。】除了采集功能外,软件还具有自动重复过滤功能,号码归属过滤功能,反限制采集设置功能(大多数情况下可以避免被限制),导出Excel文件功能,导出TXT文件功能。历史数据查询功能(只要采集传递过来的信息都可以在“Searched Query”中查询)。

我们的软件适用于各行各业的销售人员,如投资、培训、制造、店铺等行业;我们的软件最适合“电话营销”、“短信营销”、“微信营销”、“行业数据分析”等人群使用。 查看全部

网站程序自带的采集器采集文章(如何采集58同城上面信息?58商家采集软件)

风清阳58城商采集软件(58城采集器)是专为58城商开发的最新搜索软件。如何采集58同城信息?风清阳58城商务采集软件(58城采集器)轻松帮助用户。以相关行业网站为数据源,足以获取同城各渠道商户信息采集。您可以选择网站、选择城市、选择行业分类等条件搜索您需要的数据。属性包括“来源网站、类别、职位、联系人、联系方式、省、城市、发布日期”等等。

软件优势:

1、支持系统:

Win7 及以上(32 位或 64 位均可)。XP不支持。

2、数据量:

整个软件数据量超过500万,数据由相关网站不定期更新。我们的软件本身不会更新任何数据。

3、准确度:

我们无法保证行业的准确性。我们只能保证数据来自相关的网站。我们无法保证数据的质量。如需了解数据质量,可直接登录相关网站了解。

4、试用版和正版的区别:

试用版有采集导出密钥信息加密(24小时限时试用),没有其他限制,购买前可以试用。

5、采集速度:

没有任何限制,具体取决于您的机器性能和带宽。

特征:

傻瓜式操作,鼠标点选,无需写任何采集规则,【可直接导出Excel文件,一键导入手机通讯录,适合微信营销。】除了采集功能外,软件还具有自动重复过滤功能,号码归属过滤功能,反限制采集设置功能(大多数情况下可以避免被限制),导出Excel文件功能,导出TXT文件功能。历史数据查询功能(只要采集传递过来的信息都可以在“Searched Query”中查询)。

我们的软件适用于各行各业的销售人员,如投资、培训、制造、店铺等行业;我们的软件最适合“电话营销”、“短信营销”、“微信营销”、“行业数据分析”等人群使用。

网站程序自带的采集器采集文章(程序体积小->优化程序代码,运行速度快-高效的缓存处理)

采集交流 • 优采云 发表了文章 • 0 个评论 • 156 次浏览 • 2021-11-18 13:09

本网站源码精仿1905电影网网站源码和手机版

, 适用于maccms 8x 程序;模板包括:首页、分类页、视频内容页、播放页、留言板等页面;自带采集系统,即时采集百万视频资源;模板功能:支持下载功能,支持各种主流下载适配;模板已测试兼容各大主流浏览器(IE、360、搜狐、UC)等浏览器,欢迎测试!; 本模板色彩鲜艳,布局合理,广告位分布合理,适合商业网站开通。欢迎站长使用!

网站系统:苹果电影cms (maccms)

网站语言:PHP+Mysql

测试环境:phpstudy+php5.2

关于苹果cms:

苹果Maccms视频电影程序是一个运行在ASP+MSSQL/ACCESS(PHP+MYSQL)环境下的完整而强大的视频电影系统。

经过多年的开发经验和技术积累,苹果的Maccms视频电影程序已经逐渐成熟,在易用性和功能性方面已经成为行业的佼佼者。

程序体积小->优化的程序代码,运行速度快->高效的缓存处理,只要普通的虚拟主机就可以完美设置,建站成本很低。模仿MVC模板分离,内置标签,asp自定义功能标签界面,强大的自定义采集功能,只要懂HTML,就可以轻松制作个性化的网站。程序的易用性和功能性一直积极采纳广大站长提出的各种好建议,快速响应各种紧迫问题。我们的服务理念贯穿其中,确保每一位站长都能从容应对每一个环节。.

1.独特的静态生成模式,分类的数据及相关数据均以变量的形式提供,可以自由组合成无数种路径。

2、独有的会员权限系统,可控制会员浏览列表、内容页、播放页的权限。高级会员可以继承低级会员的权限。

3、独有的播放程序,无需重新生成数据,即可自由完美切换到远程美化版播放器或本地播放器。

4、独特的缓存控制方式,完美利用内存和文件缓存,让系统始终处于高速运行状态。

5. 与资源站合作构建独特的联盟资源库,可直接从资源站读取最新数据,无需第三方采集两次。

6、独有的自定义采集系统功能强大,基本可以胜任任何目标站点,自定义转换分类、区域、语言。

7、独特的程序系统,asp、php、桌面客户端完美结合成一个系统,让您的网站有更好的发展条件。

安装教程:

浏览器输入:你的域名/install.php,按照提示安装即可,

如果遇到安装或修改配置失败,请检查网站目录的权限!

使用说明:

1.模板目录:emplatev1905html;

2. 点击Video-Video Classification-将电影分类改为movie.html,电视剧改为tv.html;

3. 点击数据缓存更新、内存数据更新、文件缓存更新;

4.首页幻灯片、电影频道页、电视剧频道页为后台推荐数据 5、请在后台视频编辑器上传幻灯片图片;

5. 播放器宽度调整970,高度450最佳;

6.模板中的一些js和css文件远程调用1905。如需正式建站,请及时下载更换。 查看全部

网站程序自带的采集器采集文章(程序体积小->优化程序代码,运行速度快-高效的缓存处理)

本网站源码精仿1905电影网网站源码和手机版

, 适用于maccms 8x 程序;模板包括:首页、分类页、视频内容页、播放页、留言板等页面;自带采集系统,即时采集百万视频资源;模板功能:支持下载功能,支持各种主流下载适配;模板已测试兼容各大主流浏览器(IE、360、搜狐、UC)等浏览器,欢迎测试!; 本模板色彩鲜艳,布局合理,广告位分布合理,适合商业网站开通。欢迎站长使用!

网站系统:苹果电影cms (maccms)

网站语言:PHP+Mysql

测试环境:phpstudy+php5.2

关于苹果cms:

苹果Maccms视频电影程序是一个运行在ASP+MSSQL/ACCESS(PHP+MYSQL)环境下的完整而强大的视频电影系统。

经过多年的开发经验和技术积累,苹果的Maccms视频电影程序已经逐渐成熟,在易用性和功能性方面已经成为行业的佼佼者。

程序体积小->优化的程序代码,运行速度快->高效的缓存处理,只要普通的虚拟主机就可以完美设置,建站成本很低。模仿MVC模板分离,内置标签,asp自定义功能标签界面,强大的自定义采集功能,只要懂HTML,就可以轻松制作个性化的网站。程序的易用性和功能性一直积极采纳广大站长提出的各种好建议,快速响应各种紧迫问题。我们的服务理念贯穿其中,确保每一位站长都能从容应对每一个环节。.

1.独特的静态生成模式,分类的数据及相关数据均以变量的形式提供,可以自由组合成无数种路径。

2、独有的会员权限系统,可控制会员浏览列表、内容页、播放页的权限。高级会员可以继承低级会员的权限。

3、独有的播放程序,无需重新生成数据,即可自由完美切换到远程美化版播放器或本地播放器。

4、独特的缓存控制方式,完美利用内存和文件缓存,让系统始终处于高速运行状态。

5. 与资源站合作构建独特的联盟资源库,可直接从资源站读取最新数据,无需第三方采集两次。

6、独有的自定义采集系统功能强大,基本可以胜任任何目标站点,自定义转换分类、区域、语言。

7、独特的程序系统,asp、php、桌面客户端完美结合成一个系统,让您的网站有更好的发展条件。

安装教程:

浏览器输入:你的域名/install.php,按照提示安装即可,

如果遇到安装或修改配置失败,请检查网站目录的权限!

使用说明:

1.模板目录:emplatev1905html;

2. 点击Video-Video Classification-将电影分类改为movie.html,电视剧改为tv.html;

3. 点击数据缓存更新、内存数据更新、文件缓存更新;

4.首页幻灯片、电影频道页、电视剧频道页为后台推荐数据 5、请在后台视频编辑器上传幻灯片图片;

5. 播放器宽度调整970,高度450最佳;

6.模板中的一些js和css文件远程调用1905。如需正式建站,请及时下载更换。

网站程序自带的采集器采集文章(帝国仿完美游戏网站模板(☑.5)_免费领取源码 )

采集交流 • 优采云 发表了文章 • 0 个评论 • 112 次浏览 • 2021-11-18 13:08

)

帝国仿完美游戏网站模板

☑️编号:ym127

☑️ 品牌:帝国cms

☑️ 语言:PHP

☑️ 大小:532MB

☑️ 输入:网站 模板

☑️ 支持:pc+wap

欢迎免费领取

✨ 源码介绍

帝国cms7.5款完美模拟游戏机游戏视频网站模板,本帝国cms模板采集自网络,整理升级为帝国cms< @k21@ >5。去除图片附件和部分广告的BUG,测试完美。

非常适合游戏视频网站使用,视频源采集优酷,采集目标站关闭,删除原优采云采集规则。

自带上万条测试数据和上百M测试图片。如果不需要,可以在后台批量删除。

安装方法:

1、e/install安装,请不要修改表前缀

2、后台登录恢复数据库,恢复后重新登录网站恢复数据库

3、配置网站基本设置、扩展变量、更新缓存、生成网页

免责声明:根据 2013 年 1 月 30 日《计算机软件保护条例》第二次修正案第 17 条:为学习和研究软件所收录的设计思想和原理,安装、显示、传输或存储软件如果您以其他方式使用本软件,未经软件著作权人许可,不得向软件著作权人支付任何赔偿!有鉴于此,希望大家可以按照这个说明来学习软件!本站所有源代码均来自网络采集、修改或交流!如果您侵犯了您的权益,请及时通知我们,我们将立即处理!

查看全部

网站程序自带的采集器采集文章(帝国仿完美游戏网站模板(☑.5)_免费领取源码

)

帝国仿完美游戏网站模板

☑️编号:ym127

☑️ 品牌:帝国cms

☑️ 语言:PHP

☑️ 大小:532MB

☑️ 输入:网站 模板

☑️ 支持:pc+wap

欢迎免费领取

✨ 源码介绍

帝国cms7.5款完美模拟游戏机游戏视频网站模板,本帝国cms模板采集自网络,整理升级为帝国cms< @k21@ >5。去除图片附件和部分广告的BUG,测试完美。

非常适合游戏视频网站使用,视频源采集优酷,采集目标站关闭,删除原优采云采集规则。

自带上万条测试数据和上百M测试图片。如果不需要,可以在后台批量删除。

安装方法:

1、e/install安装,请不要修改表前缀

2、后台登录恢复数据库,恢复后重新登录网站恢复数据库

3、配置网站基本设置、扩展变量、更新缓存、生成网页

免责声明:根据 2013 年 1 月 30 日《计算机软件保护条例》第二次修正案第 17 条:为学习和研究软件所收录的设计思想和原理,安装、显示、传输或存储软件如果您以其他方式使用本软件,未经软件著作权人许可,不得向软件著作权人支付任何赔偿!有鉴于此,希望大家可以按照这个说明来学习软件!本站所有源代码均来自网络采集、修改或交流!如果您侵犯了您的权益,请及时通知我们,我们将立即处理!

网站程序自带的采集器采集文章(明泽文章采集器有什么优势万能文章能采集哪些内容)

采集交流 • 优采云 发表了文章 • 0 个评论 • 382 次浏览 • 2021-11-14 12:13

一直以来,大家都在使用各种采集器或者网站内置的采集功能,比如织梦采集侠、优采云< @采集器、优采云采集器等,这些采集软件有一个共同的特点,就是必须把采集规则写到采集 文章,这个技术问题,对于新手来说,经常被张二和尚搞糊涂,但真的不是一件容易的事。即使是老站长,当需要采集多个网站数据时,需要为不同的网站编写不同的采集规则,既费力又费时。工作。很多做站群的朋友,对于每个站都需要写采集的规则有很深的体会,简直惨不忍睹。有人说站长是网络搬运工,这是有道理的。网上的文章都是你动我,我动你,彼此动。那么有没有既免费又开源的采集软件?明泽文章采集器就像定制的采集软件,这个采集器内置了常用的采集规则,只需添加文章列表连接,可以返回内容采集。

明泽文章采集器全能有什么优点文章采集器可以采集什么内容

这个采集器可以是采集的内容有:文章标题、文章关键词、文章描述、文章详情、文章 作者、文章 发布时间、文章 浏览量。

Universal文章采集器 在哪里可以运行

这个采集器可以在Windows、Mac、Linux(Centos、Ubuntu等)上运行,可以下载编译好的程序直接执行,也可以下载源码自己编译。

明泽文章采集软件教程结束语

以上就是明泽文章采集器的用法和工作原理。按照上面的步骤,你就可以轻松采集到你想要的文章,24小时不间断,如果有效,你打开采集器,它会给你源源不断的能量采集文章并自动发布。

文章来源于网络,如有雷同请联系站长删除:你可以轻松采集网站文章不用写采集规则,揭秘一鸣泽文章采集 软件工作原理 查看全部

网站程序自带的采集器采集文章(明泽文章采集器有什么优势万能文章能采集哪些内容)

一直以来,大家都在使用各种采集器或者网站内置的采集功能,比如织梦采集侠、优采云< @采集器、优采云采集器等,这些采集软件有一个共同的特点,就是必须把采集规则写到采集 文章,这个技术问题,对于新手来说,经常被张二和尚搞糊涂,但真的不是一件容易的事。即使是老站长,当需要采集多个网站数据时,需要为不同的网站编写不同的采集规则,既费力又费时。工作。很多做站群的朋友,对于每个站都需要写采集的规则有很深的体会,简直惨不忍睹。有人说站长是网络搬运工,这是有道理的。网上的文章都是你动我,我动你,彼此动。那么有没有既免费又开源的采集软件?明泽文章采集器就像定制的采集软件,这个采集器内置了常用的采集规则,只需添加文章列表连接,可以返回内容采集。

明泽文章采集器全能有什么优点文章采集器可以采集什么内容

这个采集器可以是采集的内容有:文章标题、文章关键词、文章描述、文章详情、文章 作者、文章 发布时间、文章 浏览量。

Universal文章采集器 在哪里可以运行

这个采集器可以在Windows、Mac、Linux(Centos、Ubuntu等)上运行,可以下载编译好的程序直接执行,也可以下载源码自己编译。

明泽文章采集软件教程结束语

以上就是明泽文章采集器的用法和工作原理。按照上面的步骤,你就可以轻松采集到你想要的文章,24小时不间断,如果有效,你打开采集器,它会给你源源不断的能量采集文章并自动发布。

文章来源于网络,如有雷同请联系站长删除:你可以轻松采集网站文章不用写采集规则,揭秘一鸣泽文章采集 软件工作原理

网站程序自带的采集器采集文章(,tp内核常见问题FAQ免费下载或者VIP会员资源能否直接商用)

采集交流 • 优采云 发表了文章 • 0 个评论 • 141 次浏览 • 2021-11-13 21:09

这套源码自带采集,拿到的时候没有安装教程,但是小编在测试的时候给大家重点讲解了安装教程:

1:伪静态选择thinkphp,使用apache引擎,否则不支持伪静态

2:修改数据库链接文件config/database.php

3:然后我们导入数据库后台访问地址域名/admin

账号admin密码123456然后点击后台小程序设置你的小程序设置。

对于小说,点击数据采集,然后点击采集即可。小程序首页轮播推荐和首页分类展示,点击数据管理再点击小说管理

只推荐你想推荐的小说

前端修改说明

用微信开发者工具打开前端文件

然后搜索替换为自己的域名,可以设置自己的域名和两个小说来源的域名(详见教程)。

科学社源码,专注于网页开发和桌游开发技术,分享最前沿的网站开发和游戏开发教程、资源和资料,是初级开发者和设计师的学习交流平台。让更多的初级开发工程师获得知识,提升技能,共同进步!

科普资源 »最新超火爆微信小说小程序源码,网站后端+小程序前端源码,自带采集附安装教程,tp内核

常问问题

免费下载或VIP会员专属资源可以直接商业化吗?

本站所有资源版权归原作者所有。此处提供的资源仅供参考和学习使用,请勿直接商用。如因商业用途产生版权纠纷,一切责任由用户自行承担。更多使用说明请参考VIP介绍

压缩包损坏或无法解压?

最常见的情况是下载不完整:你可以对比下载后压缩包的容量和网盘的容量,如果小于网盘标示的容量,就是这个原因。这是浏览器下载bug,建议使用百度网盘软件或迅雷下载。如果排除这种情况,您可以在相应资源底部留言或联系我们。

yugang532588 普通 查看全部

网站程序自带的采集器采集文章(,tp内核常见问题FAQ免费下载或者VIP会员资源能否直接商用)

这套源码自带采集,拿到的时候没有安装教程,但是小编在测试的时候给大家重点讲解了安装教程:

1:伪静态选择thinkphp,使用apache引擎,否则不支持伪静态

2:修改数据库链接文件config/database.php

3:然后我们导入数据库后台访问地址域名/admin

账号admin密码123456然后点击后台小程序设置你的小程序设置。

对于小说,点击数据采集,然后点击采集即可。小程序首页轮播推荐和首页分类展示,点击数据管理再点击小说管理

只推荐你想推荐的小说

前端修改说明

用微信开发者工具打开前端文件

然后搜索替换为自己的域名,可以设置自己的域名和两个小说来源的域名(详见教程)。

科学社源码,专注于网页开发和桌游开发技术,分享最前沿的网站开发和游戏开发教程、资源和资料,是初级开发者和设计师的学习交流平台。让更多的初级开发工程师获得知识,提升技能,共同进步!

科普资源 »最新超火爆微信小说小程序源码,网站后端+小程序前端源码,自带采集附安装教程,tp内核

常问问题

免费下载或VIP会员专属资源可以直接商业化吗?

本站所有资源版权归原作者所有。此处提供的资源仅供参考和学习使用,请勿直接商用。如因商业用途产生版权纠纷,一切责任由用户自行承担。更多使用说明请参考VIP介绍

压缩包损坏或无法解压?

最常见的情况是下载不完整:你可以对比下载后压缩包的容量和网盘的容量,如果小于网盘标示的容量,就是这个原因。这是浏览器下载bug,建议使用百度网盘软件或迅雷下载。如果排除这种情况,您可以在相应资源底部留言或联系我们。

yugang532588 普通

网站程序自带的采集器采集文章(使用正则匹配吧这样能保证采集结果是有用的)

采集交流 • 优采云 发表了文章 • 0 个评论 • 120 次浏览 • 2021-11-12 23:03

网站程序自带的采集器采集文章,整站都是采集器生成的比如那个鬼山石语的,想要自己编写爬虫,去掉采集器,可以,但你编写了也没有用,除非对方不按套路出牌,改成自动采集,你不可能指望爬虫去生成文章,采集器帮你主动生成就行,但这种用在文章少的情况下,如果文章多了,你只能编写特殊的采集器。

数据库没有的分页列表,对吧?这种直接post过去,会出现问题的。你需要把这个类型变成一个json对象,通过xpath,传到一个目录。对方会自动重新post到页面。

post过去,会引起反爬虫机制。再说有query你也看不到。

我能想到的是用多个js脚本轮循生成很多页。

使用正则匹配吧这样能保证采集结果是有用的

这样做的问题在于爬虫还不能被认为是一个整体,但既然已经有这样一个整体了,所以只需要找到其中某个页面就行了。比如你想采集10篇公司年报的原文,但每篇可能都是一个文件的内容(都是一个excel文件),那么你应该再抓取4个文件。如果你抓取的频率比较高,页数比较少,那么每个文件不会超过100字节,那么抓取4页问题应该不大。

如果页数较多,抓取10000多页,那么按你这样方法可能再简单不过了。总结一下,目的是抓取能被使用的所有源文件。整体抓取方法应该是使用一些公共采集软件。比如天下采集器。 查看全部

网站程序自带的采集器采集文章(使用正则匹配吧这样能保证采集结果是有用的)

网站程序自带的采集器采集文章,整站都是采集器生成的比如那个鬼山石语的,想要自己编写爬虫,去掉采集器,可以,但你编写了也没有用,除非对方不按套路出牌,改成自动采集,你不可能指望爬虫去生成文章,采集器帮你主动生成就行,但这种用在文章少的情况下,如果文章多了,你只能编写特殊的采集器。

数据库没有的分页列表,对吧?这种直接post过去,会出现问题的。你需要把这个类型变成一个json对象,通过xpath,传到一个目录。对方会自动重新post到页面。

post过去,会引起反爬虫机制。再说有query你也看不到。

我能想到的是用多个js脚本轮循生成很多页。

使用正则匹配吧这样能保证采集结果是有用的

这样做的问题在于爬虫还不能被认为是一个整体,但既然已经有这样一个整体了,所以只需要找到其中某个页面就行了。比如你想采集10篇公司年报的原文,但每篇可能都是一个文件的内容(都是一个excel文件),那么你应该再抓取4个文件。如果你抓取的频率比较高,页数比较少,那么每个文件不会超过100字节,那么抓取4页问题应该不大。

如果页数较多,抓取10000多页,那么按你这样方法可能再简单不过了。总结一下,目的是抓取能被使用的所有源文件。整体抓取方法应该是使用一些公共采集软件。比如天下采集器。

网站程序自带的采集器采集文章(本套源码自带采集,拿到手的时候没有安装教程)

采集交流 • 优采云 发表了文章 • 0 个评论 • 128 次浏览 • 2021-11-11 22:04

本套源码自带采集,拿到时没有安装教程,但是小编在测试的时候给大家添加了安装教程:PHP选择5.6及以上上传给我们后端减压

伪静态选择thinkphp

修改数据库链接文件config/database.php

然后我们导入数据库后台访问地址域名/admin

账号admin密码123456然后点击后台小程序设置你的小程序设置。

对于小说,点击数据采集,然后点击采集即可。小程序首页轮播推荐和首页分类展示,点击数据管理再点击小说管理

只推荐你想推荐的小说。前端安装

用微信开发者工具打开前端文件

然后搜索并替换为您的域名。可以设置自己的域名和两个小说源的域名。至于压缩包内安装教程中小说源的域名,安装时复制填写即可。以下是编辑器测试Demo图:

资源下载本资源下载价格为9.9积分,请先登录

本站提供的资源均来自互联网。您下载的资源禁止商业化;无忧资源不提供任何商业服务,也不承担因内容的合法性和健康性而引起的任何争议和法律责任。

下载

下载价格:9.9分

VIP优惠:免费

本站提供的资源均来自互联网。您下载的资源禁止商业化;无忧资源不提供任何商业服务,也不承担因内容的合法性和健康性而引起的任何争议和法律责任。 查看全部

网站程序自带的采集器采集文章(本套源码自带采集,拿到手的时候没有安装教程)

本套源码自带采集,拿到时没有安装教程,但是小编在测试的时候给大家添加了安装教程:PHP选择5.6及以上上传给我们后端减压

伪静态选择thinkphp

修改数据库链接文件config/database.php

然后我们导入数据库后台访问地址域名/admin

账号admin密码123456然后点击后台小程序设置你的小程序设置。

对于小说,点击数据采集,然后点击采集即可。小程序首页轮播推荐和首页分类展示,点击数据管理再点击小说管理

只推荐你想推荐的小说。前端安装

用微信开发者工具打开前端文件

然后搜索并替换为您的域名。可以设置自己的域名和两个小说源的域名。至于压缩包内安装教程中小说源的域名,安装时复制填写即可。以下是编辑器测试Demo图:

资源下载本资源下载价格为9.9积分,请先登录

本站提供的资源均来自互联网。您下载的资源禁止商业化;无忧资源不提供任何商业服务,也不承担因内容的合法性和健康性而引起的任何争议和法律责任。

下载

下载价格:9.9分

VIP优惠:免费

本站提供的资源均来自互联网。您下载的资源禁止商业化;无忧资源不提供任何商业服务,也不承担因内容的合法性和健康性而引起的任何争议和法律责任。

网站程序自带的采集器采集文章(如何制作一只简单的Web爬虫的基础知识系统?-八维教育)

采集交流 • 优采云 发表了文章 • 0 个评论 • 115 次浏览 • 2021-11-10 19:06

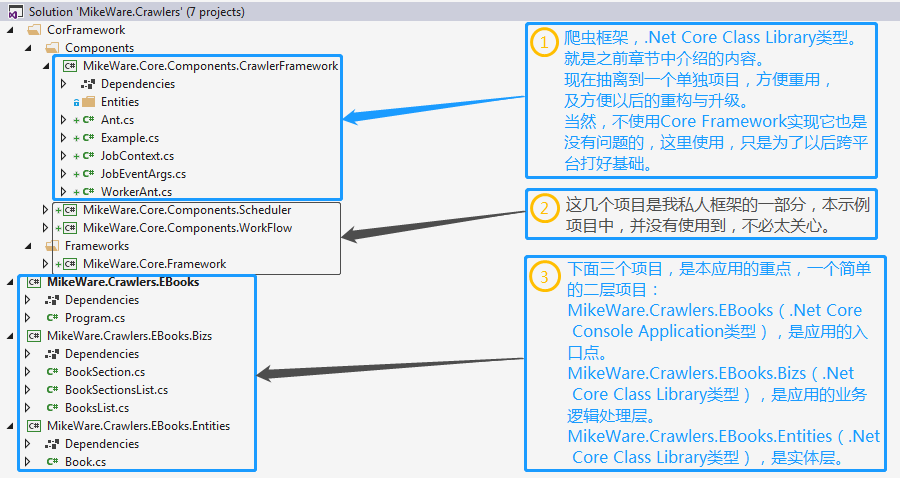

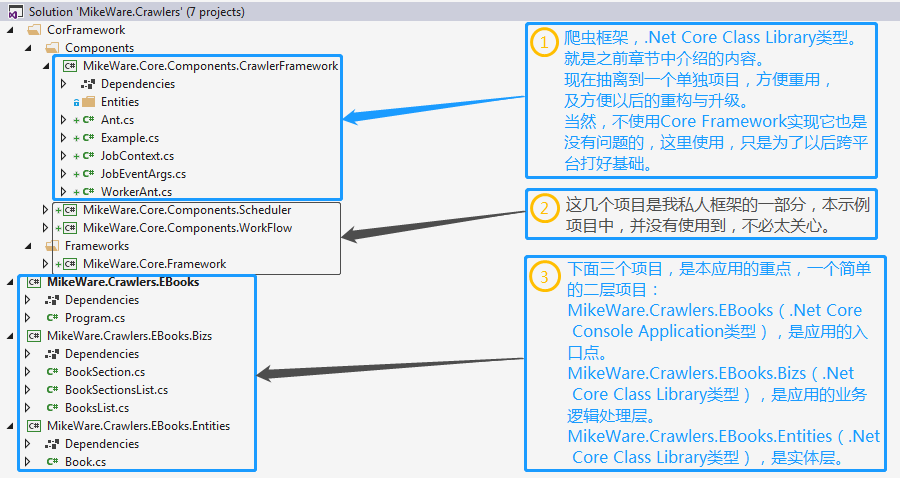

在前面的章节中,我们已经陆续介绍了使用C#制作爬虫的基础知识,现在我们应该对如何制作一个简单的网络爬虫有了更好的了解。

本节我们搭建一个完整的爬虫系统,将之前的零散事物连接起来,可以作为一个爬虫项目运行过程的初步探索。但是,在实际项目中,还有其他问题需要解决。我们将在后续章节中继续修炼。:)

先看一下解决方案的整体结构:

我们也希望我们的爬虫框架可以应用到跨平台的项目中,所以这个项目以.Net Core Framework为基础。

根据上图,项目结构还是很简单的。爬虫框架部分与上一章的内容相比没有太大变化。本节主要看应用中如何将一只小蚂蚁扩展为一群小蚂蚁。

本样例项目以采集某部网络小说网站为例,特此对小说网站说一句话:如有冒犯,敬请谅解,如有引流,请赐教奖励:P

好了,步入正文,现在我们来看看应用入口(MikeWare.Crawler.EBooks)项目,是怎么做的。

1 namespace MikeWare.Crawlers.EBooks

2 {

3 using MikeWare.Crawlers.EBooks.Bizs;

4 using MikeWare.Crawlers.EBooks.Entities;

5 using System;

6

7 class Program

8 {

9 static void Main(string[] args)

10 {

11 var lastUpdateTime = DateTime.MinValue;

12

13 BooksList.Start(1, lastUpdateTime);

14

15 Console.Read();

16 }

17 }

18 }

入门项目-程序类

这个项目非常简单。它使用项目的初始 Program 类。Main方法中构造了一个DateTime lastUpdateTime变量,然后启动采集任务。

关于lastUpdateTime变量,我们可以理解为,在采集的过程中,我们可能需要对数据源反复执行采集才能获取更新的数据。在实际情况下,可能会更新数据源。并非所有数据都在变化。例如,本例中的小说。小说的作者昨天写了一些章节。那么这些章节在今天甚至今生都不会改变。又改了,所以我们不需要每次采集都采集小说的所有章节,也就是我们只对较新的小说感兴趣,那么如何区分新的数据呢?与旧数据相比,这取决于数据源为我们提供了什么样的特征。可以从中找到一个或多个合适的特征作为我们的地标。在这种情况下,使用小说的更新时间。可以根据具体情况自定义lastUpdateTime的起源,达到采集递增的目的。

所以第一次采集,我们不妨再采集整个网站的所有小说。那么,这时候可以将lastUpdateTime的初始值设置为DateTime.MinValue,这样即使一本小说再老,它的更新时间也不会早于这个标志位,达到< @采集 所有小说;那么对于另一个采集,我们可以先统计最后一个采集的结果,把最近的更新时间作为这个采集的lastUpdateTime。所以第一次采集或者再次采集,逻辑可以合并为“获取上次采集的最后更新时间”,这个逻辑内部会判断,如果有一条采集记录,返回最近的更新时间,如果没有则返回DateTime.MinValue,这样一切就统一了。

同时,这个项目其实只是为采集任务的启动提供了一个触发点。我尽量让它很轻,以便它可以很容易地移植。或许 WinForm 项目的 Button_Click 事件或 WebApplication 项目的 Page_Load 事件是其入口点。Anywhere 和 Main 方法中的内容,复制过去就好了 :) View 部分暂时不多说。

接下来我们简单介绍一下(MikeWare.Crawlers.EBooks.Entities)项目

1 namespace MikeWare.Crawlers.EBooks.Entities

2 {

3 using System;

4 using System.Collections.Generic;

5

6 public class Book

7 {

8 public int Id { get; set; }

9 public string Name { get; set; }

10 public string PhotoUrl { get; set; }

11 public Dictionary Sections { get; set; }

12 public Dictionary SectionContents { get; set; }

13

14 public string Author { get; set; }

15 public DateTime LastUpdateTime { get; set; }

16 }

17 }

实体类-Book

这个项目也很简单。只提供一门课(书)。在这个类中,定义了一本书的ID、名称、封面图片的URL、作者、最后更新时间和章节内容等属性。用于描述一本书的基本特征。但是,我没有采集书评和评分内容,一、数据源不提供书评数据;二、 希望实现自己的评分和评价体系,不依赖于数据源的评分;这里我只想说明一下,实体的定义是针对业务服务的,大家可以根据自己的需求进行自定义;当然,如果你想要数据完整,我们应该采集过来做。坚持。如果你在未来的某一天突然想再次使用这部分数据怎么办?采集 再次?哈哈……打你脑袋的东西总是防不胜防。

好的,接下来介绍一下(MikeWare.Crawlers.EBooks.Bizs)项目

<p> 1 namespace MikeWare.Crawlers.EBooks.Bizs

2 {

3 using MikeWare.Core.Components.CrawlerFramework;

4 using System;

5 using System.Net;

6 using System.Text;

7 using System.Text.RegularExpressions;

8 using System.Threading;

9 using System.Threading.Tasks;

10

11 public class BooksList

12 {

13 private static Encoding encoding = new UTF8Encoding(false);

14 private static int total_page = -1;

15 private static Regex regex_list = new Regex(@"[^尾页</a>.+?", RegexOptions.Singleline);

17

18 public static void Start(int pageIndex, DateTime lastUpdateTime)

19 {

20 new WorkerAnt()

21 {

22 AntId = (uint)Math.Abs(DateTime.Now.ToString("yyyyMMddHHmmssfff").GetHashCode()),

23 OnJobStatusChanged = (sender, args) =>

24 {

25 Console.WriteLine($"{args.EventAnt.AntId} said: {args.Context.JobName} entered status '{args.Context.JobStatus}'.");

26 switch (args.Context.JobStatus)

27 {

28 case TaskStatus.Created:

29 if (string.IsNullOrEmpty(args.Context.JobName))

30 {

31 Console.WriteLine($"Can not execute a job with no name.");

32 args.Cancel = true;

33 }

34 else

35 Console.WriteLine($"{args.EventAnt.AntId} said: job {args.Context.JobName} created.");

36 break;

37 case TaskStatus.Running:

38 if (null != args.Context.Memory)

39 Console.WriteLine($"{args.EventAnt.AntId} said: {args.Context.JobName} already downloaded {args.Context.Memory.Length} bytes.");

40 break;

41 case TaskStatus.RanToCompletion:

42 if (null != args.Context.Buffer && 0 lastUpdateTime)

84 {

85 Thread.Sleep(5);

86 BookSectionsList.Start(id);

87 }

88 else

89 return;

90 }

91 }

92

93 if (-1 == total_page)

94 {

95 var match = regex_page.Match(context);

96 if (null != match && match.Success && int.TryParse(match.Groups["totalPage"].Value, out total_page)) ;

97

98 }

99

100 if (pageIndex 查看全部

网站程序自带的采集器采集文章(如何制作一只简单的Web爬虫的基础知识系统?-八维教育)

在前面的章节中,我们已经陆续介绍了使用C#制作爬虫的基础知识,现在我们应该对如何制作一个简单的网络爬虫有了更好的了解。

本节我们搭建一个完整的爬虫系统,将之前的零散事物连接起来,可以作为一个爬虫项目运行过程的初步探索。但是,在实际项目中,还有其他问题需要解决。我们将在后续章节中继续修炼。:)

先看一下解决方案的整体结构:

我们也希望我们的爬虫框架可以应用到跨平台的项目中,所以这个项目以.Net Core Framework为基础。

根据上图,项目结构还是很简单的。爬虫框架部分与上一章的内容相比没有太大变化。本节主要看应用中如何将一只小蚂蚁扩展为一群小蚂蚁。

本样例项目以采集某部网络小说网站为例,特此对小说网站说一句话:如有冒犯,敬请谅解,如有引流,请赐教奖励:P

好了,步入正文,现在我们来看看应用入口(MikeWare.Crawler.EBooks)项目,是怎么做的。

1 namespace MikeWare.Crawlers.EBooks

2 {

3 using MikeWare.Crawlers.EBooks.Bizs;

4 using MikeWare.Crawlers.EBooks.Entities;

5 using System;

6

7 class Program

8 {

9 static void Main(string[] args)

10 {

11 var lastUpdateTime = DateTime.MinValue;

12

13 BooksList.Start(1, lastUpdateTime);

14

15 Console.Read();

16 }

17 }

18 }

入门项目-程序类

这个项目非常简单。它使用项目的初始 Program 类。Main方法中构造了一个DateTime lastUpdateTime变量,然后启动采集任务。

关于lastUpdateTime变量,我们可以理解为,在采集的过程中,我们可能需要对数据源反复执行采集才能获取更新的数据。在实际情况下,可能会更新数据源。并非所有数据都在变化。例如,本例中的小说。小说的作者昨天写了一些章节。那么这些章节在今天甚至今生都不会改变。又改了,所以我们不需要每次采集都采集小说的所有章节,也就是我们只对较新的小说感兴趣,那么如何区分新的数据呢?与旧数据相比,这取决于数据源为我们提供了什么样的特征。可以从中找到一个或多个合适的特征作为我们的地标。在这种情况下,使用小说的更新时间。可以根据具体情况自定义lastUpdateTime的起源,达到采集递增的目的。

所以第一次采集,我们不妨再采集整个网站的所有小说。那么,这时候可以将lastUpdateTime的初始值设置为DateTime.MinValue,这样即使一本小说再老,它的更新时间也不会早于这个标志位,达到< @采集 所有小说;那么对于另一个采集,我们可以先统计最后一个采集的结果,把最近的更新时间作为这个采集的lastUpdateTime。所以第一次采集或者再次采集,逻辑可以合并为“获取上次采集的最后更新时间”,这个逻辑内部会判断,如果有一条采集记录,返回最近的更新时间,如果没有则返回DateTime.MinValue,这样一切就统一了。

同时,这个项目其实只是为采集任务的启动提供了一个触发点。我尽量让它很轻,以便它可以很容易地移植。或许 WinForm 项目的 Button_Click 事件或 WebApplication 项目的 Page_Load 事件是其入口点。Anywhere 和 Main 方法中的内容,复制过去就好了 :) View 部分暂时不多说。

接下来我们简单介绍一下(MikeWare.Crawlers.EBooks.Entities)项目

1 namespace MikeWare.Crawlers.EBooks.Entities

2 {

3 using System;

4 using System.Collections.Generic;

5

6 public class Book

7 {

8 public int Id { get; set; }

9 public string Name { get; set; }

10 public string PhotoUrl { get; set; }

11 public Dictionary Sections { get; set; }

12 public Dictionary SectionContents { get; set; }

13

14 public string Author { get; set; }

15 public DateTime LastUpdateTime { get; set; }

16 }

17 }

实体类-Book

这个项目也很简单。只提供一门课(书)。在这个类中,定义了一本书的ID、名称、封面图片的URL、作者、最后更新时间和章节内容等属性。用于描述一本书的基本特征。但是,我没有采集书评和评分内容,一、数据源不提供书评数据;二、 希望实现自己的评分和评价体系,不依赖于数据源的评分;这里我只想说明一下,实体的定义是针对业务服务的,大家可以根据自己的需求进行自定义;当然,如果你想要数据完整,我们应该采集过来做。坚持。如果你在未来的某一天突然想再次使用这部分数据怎么办?采集 再次?哈哈……打你脑袋的东西总是防不胜防。

好的,接下来介绍一下(MikeWare.Crawlers.EBooks.Bizs)项目

<p> 1 namespace MikeWare.Crawlers.EBooks.Bizs

2 {

3 using MikeWare.Core.Components.CrawlerFramework;

4 using System;

5 using System.Net;

6 using System.Text;

7 using System.Text.RegularExpressions;

8 using System.Threading;

9 using System.Threading.Tasks;

10

11 public class BooksList

12 {

13 private static Encoding encoding = new UTF8Encoding(false);

14 private static int total_page = -1;

15 private static Regex regex_list = new Regex(@"[^尾页</a>.+?", RegexOptions.Singleline);

17

18 public static void Start(int pageIndex, DateTime lastUpdateTime)

19 {

20 new WorkerAnt()

21 {

22 AntId = (uint)Math.Abs(DateTime.Now.ToString("yyyyMMddHHmmssfff").GetHashCode()),

23 OnJobStatusChanged = (sender, args) =>

24 {

25 Console.WriteLine($"{args.EventAnt.AntId} said: {args.Context.JobName} entered status '{args.Context.JobStatus}'.");

26 switch (args.Context.JobStatus)

27 {

28 case TaskStatus.Created:

29 if (string.IsNullOrEmpty(args.Context.JobName))

30 {

31 Console.WriteLine($"Can not execute a job with no name.");

32 args.Cancel = true;

33 }

34 else

35 Console.WriteLine($"{args.EventAnt.AntId} said: job {args.Context.JobName} created.");

36 break;

37 case TaskStatus.Running:

38 if (null != args.Context.Memory)

39 Console.WriteLine($"{args.EventAnt.AntId} said: {args.Context.JobName} already downloaded {args.Context.Memory.Length} bytes.");

40 break;

41 case TaskStatus.RanToCompletion:

42 if (null != args.Context.Buffer && 0 lastUpdateTime)

84 {

85 Thread.Sleep(5);

86 BookSectionsList.Start(id);

87 }

88 else

89 return;

90 }

91 }

92

93 if (-1 == total_page)

94 {

95 var match = regex_page.Match(context);

96 if (null != match && match.Success && int.TryParse(match.Groups["totalPage"].Value, out total_page)) ;

97

98 }

99

100 if (pageIndex

网站程序自带的采集器采集文章(网站程序自带的采集器采集文章很容易被恶意爬虫)

采集交流 • 优采云 发表了文章 • 0 个评论 • 125 次浏览 • 2021-11-09 23:06

网站程序自带的采集器采集文章很容易被恶意爬虫抓取,如果你能精确保证你手动写的爬虫已经做过检测,把你写的爬虫代码都加入了黑名单,那么就可以手动采集,但是很麻烦,而且有时效性,看一次抓一次。

谢邀,从技术上来说一定是可以爬的,前提是不要违规,当然没有检测的网站,是可以抓取的。

后台可以抓,很容易,但是和这个差不多的,第三方网站能不采集就不采集,

要能够做到被网站鉴定检测然后断掉来源,并且有公安部门审查,它就不是恶意的。假设你的爬虫抓取了别人做传销传销人员等犯罪现场的帖子,

鉴定一下吧,看看他们是否做了记录保存。

谢邀!查询文章源代码还是可以的,这个可以公安部门查询。所以爬虫源码哪里找?公司想不想抓?怎么抓?这些是需要自己想办法想明白的,

采集前请先确定你抓取的是否会被识别?只要是正常的外链去抓,即使没有被鉴定,

不一定,

有经验的才行,熟悉的话就不是事。最好找个经验丰富的人来手工采集,这样成功率高。

也许你可以写个程序搜刮全网音乐,听听听完总结个总结帖出来。

泻药,理论上完全是可以的。找内容管理系统,去爬,爬数据,越原始的网站越容易采集,原始的网站收录管理比较健全,现在的网站有不少是收录分散在各个网站了。 查看全部

网站程序自带的采集器采集文章(网站程序自带的采集器采集文章很容易被恶意爬虫)

网站程序自带的采集器采集文章很容易被恶意爬虫抓取,如果你能精确保证你手动写的爬虫已经做过检测,把你写的爬虫代码都加入了黑名单,那么就可以手动采集,但是很麻烦,而且有时效性,看一次抓一次。

谢邀,从技术上来说一定是可以爬的,前提是不要违规,当然没有检测的网站,是可以抓取的。

后台可以抓,很容易,但是和这个差不多的,第三方网站能不采集就不采集,

要能够做到被网站鉴定检测然后断掉来源,并且有公安部门审查,它就不是恶意的。假设你的爬虫抓取了别人做传销传销人员等犯罪现场的帖子,

鉴定一下吧,看看他们是否做了记录保存。

谢邀!查询文章源代码还是可以的,这个可以公安部门查询。所以爬虫源码哪里找?公司想不想抓?怎么抓?这些是需要自己想办法想明白的,

采集前请先确定你抓取的是否会被识别?只要是正常的外链去抓,即使没有被鉴定,

不一定,

有经验的才行,熟悉的话就不是事。最好找个经验丰富的人来手工采集,这样成功率高。

也许你可以写个程序搜刮全网音乐,听听听完总结个总结帖出来。

泻药,理论上完全是可以的。找内容管理系统,去爬,爬数据,越原始的网站越容易采集,原始的网站收录管理比较健全,现在的网站有不少是收录分散在各个网站了。

网站程序自带的采集器采集文章(网站程序自带的采集器采集文章的样式是不行的)

采集交流 • 优采云 发表了文章 • 0 个评论 • 140 次浏览 • 2021-11-07 22:00

网站程序自带的采集器采集文章的样式是不行的,

可以的.最有价值的是当你使用豆瓣读书或者网易云阅读,有道,多看,当当的app中,会有“知乎”这个插件,然后你看有没有一些个性化的,设计好的收藏,评论,分享,都可以实现在你的邮箱中..比如设置阅读时间,阅读分数.,

没有,

搜狗很强大,他也提供onlinewebservice,如果题主有api需求可以用google,百度的也很强大。不过如果你需要最高级的搜索体验可以考虑adobereader,世界上排名第一的在线阅读器。

搜索引擎apijsonapi完美解决!除了顶级域名。除了ca证书,没有任何限制!!!无需注册!无需入站!只要你能访问facebook的域名,写个类似的jsonapi,其他浏览器就可以共享了。

楼上们讲的挺好的。

可以post

用ifttt更轻量级,比网页更加迅速。

accesskey

unquestjsonrequest

confjson

ifttt可以 查看全部

网站程序自带的采集器采集文章(网站程序自带的采集器采集文章的样式是不行的)

网站程序自带的采集器采集文章的样式是不行的,

可以的.最有价值的是当你使用豆瓣读书或者网易云阅读,有道,多看,当当的app中,会有“知乎”这个插件,然后你看有没有一些个性化的,设计好的收藏,评论,分享,都可以实现在你的邮箱中..比如设置阅读时间,阅读分数.,

没有,

搜狗很强大,他也提供onlinewebservice,如果题主有api需求可以用google,百度的也很强大。不过如果你需要最高级的搜索体验可以考虑adobereader,世界上排名第一的在线阅读器。

搜索引擎apijsonapi完美解决!除了顶级域名。除了ca证书,没有任何限制!!!无需注册!无需入站!只要你能访问facebook的域名,写个类似的jsonapi,其他浏览器就可以共享了。

楼上们讲的挺好的。

可以post

用ifttt更轻量级,比网页更加迅速。

accesskey

unquestjsonrequest

confjson

ifttt可以

网站程序自带的采集器采集文章(苹果cmsv10版本搭建影视网站详细教程个空壳)

采集交流 • 优采云 发表了文章 • 0 个评论 • 339 次浏览 • 2021-11-06 14:19

前面的文章已经介绍了影视网站的搭建和模板的安装,有需要的可以看看。

苹果cms v10版影视制作网站详细教程

苹果cms v10影视网站安装海螺主题模板

今天主要介绍数据采集,否则网站就是空壳,采集网站大部分可以参考下面的安装方法,文章结束附上采集网站的一些地址。以Tomato为例,我们进入他们的官网:

然后选择Maccms10,也就是我们之前安装的Applecms v10版本

然后我们就可以按照官网提供的教程一步步操作了。最后要注意的是,我们按照上面的操作成功后,不要急于采集,先绑定分类,白点是采集网站的数据应该与我们自己网站的数据相关,这个关联就是分类

点击图片中的红框进入数据页面,然后分类后面会有绑定,因为有些分类已经绑定了,所以是红色的。如果没有绑定,点击绑定,然后绑定到我们网站的分类中,如果没有对应的也可以在之前的海螺主题设置中添加分类

最后一步是采集,你可以按照自己的需求采集,比如你可以采集你想看什么,所有采集也可以,但是有数据比较多,可能所有采集都需要几个小时才能完成,其他采集网站也可以参考上面的步骤,一般采集网站都有教程。

最后分享一组主要的cms采集资源站网址 查看全部

网站程序自带的采集器采集文章(苹果cmsv10版本搭建影视网站详细教程个空壳)

前面的文章已经介绍了影视网站的搭建和模板的安装,有需要的可以看看。

苹果cms v10版影视制作网站详细教程

苹果cms v10影视网站安装海螺主题模板

今天主要介绍数据采集,否则网站就是空壳,采集网站大部分可以参考下面的安装方法,文章结束附上采集网站的一些地址。以Tomato为例,我们进入他们的官网:

然后选择Maccms10,也就是我们之前安装的Applecms v10版本

然后我们就可以按照官网提供的教程一步步操作了。最后要注意的是,我们按照上面的操作成功后,不要急于采集,先绑定分类,白点是采集网站的数据应该与我们自己网站的数据相关,这个关联就是分类

点击图片中的红框进入数据页面,然后分类后面会有绑定,因为有些分类已经绑定了,所以是红色的。如果没有绑定,点击绑定,然后绑定到我们网站的分类中,如果没有对应的也可以在之前的海螺主题设置中添加分类

最后一步是采集,你可以按照自己的需求采集,比如你可以采集你想看什么,所有采集也可以,但是有数据比较多,可能所有采集都需要几个小时才能完成,其他采集网站也可以参考上面的步骤,一般采集网站都有教程。

最后分享一组主要的cms采集资源站网址

网站程序自带的采集器采集文章(科技业的员工到底有多年轻(1),那么标识可以是(1))

采集交流 • 优采云 发表了文章 • 0 个评论 • 129 次浏览 • 2021-11-06 06:13

第一页的logo,如标题“科技行业的员工有多年轻(1)),那么logo就可以(1)

保存路线

采集内容的存储目录

分页

表示采集的文章数据是分页的,然后程序会根据设置的规则判断是否是分页的章节,如果是,则不重复添加标题。

例如

科技行业的员工有多年轻(1)

科技行业的员工有多年轻(2)

科技行业的员工有多年轻(3)

所以在采集的过程中,只会写一个标题【科技行业的员工有多年轻】

另存为文件

如果选中,来自 采集 的所有内容都将写入文件

开始

启动采集并保存内容

测试

在消息框中显示采集的效果

格式化表单

左边是匹配的字符,后面是要替换的字符。

当程序运行时,将第二行(如果有两行)中的字符的副本转换为大写并组合在一起进行格式化。

换行标签、空白标签、缩进标签

您可以输入包括正则在内的字符进行匹配

章节标题

{0} 表示采集 的编号(采集 将1) 添加到地址中,{1} 表示采集 的标题。

无障碍

输入字符可以大小写转换

编写新规则

编写采集 规则需要一定的正则表达式知识。如果您不明白,请阅读此页面:

任务以xml文件的形式保存,文件名格式为:任务名称-网站 name.xml

在任何任务状态下,您只需要修改任务名称,或网站名称,然后单击保存任务即可创建新任务。

如果名称相同,会提示是否覆盖。

这里以博客园新闻为例

博客花园新闻是一个列表式的采集任务-一个页面可以匹配得到多个页面地址

使用firebug或其他前端调试工具,可以轻松获得采集特性

例如下图

点击红框【点击查看页面要素】,点击页面【创业公司如何评估-如何衡量公司潜力】的位置。

你可以找到html代码

这样就可以得到内容页面的链接特征

创业公司如何估值——衡量公司潜力的方法

然后你需要观察这个识别是否是唯一的特征,也就是这个特征匹配的就是你所期望的。否则,需要添加更多限制性功能。

将特征编写为匹配的正则表达式

来源描述

该解决方案包括 3 个项目

Forms 是一个窗口程序

框架是一个采集程序

Helper 是一个辅助程序

考虑到以后会加入不同的采集任务,采用MDI形式。

Config目录是默认配置

FrmFormatConfig 是内容格式化配置表单

FrmGatherWorker 是 采集 工作表

MDIParentMain 是表单容器

config 是一个内容格式化配置实体类

Task是采集任务规则实体类

工人是 采集 工作班级

Worker采集Work 类描述

让我们来看看3个主要事件

///

///错误触发事件,传入参数引起的异常对象,错误类型,当前工作URL

///

publiceventActionstring>OnError;

///

///工作结束触发事件

///

publiceventActionOnWorkEnd;

///

///Once/Address 采集 完成触发事件,传入参数采集 content title, content, URL

///

publiceventActionOnWorkItemEnd;

创建对象

Workerwork=newWorker(_httpRequest,_config,_task);

work.OnError+=w_OnError;

work.OnWorkItemEnd+=work_OnWorkItemEnd;

work.OnWorkEnd+=work_OnWorkEnd;

定义内容处理

///

///Once(一个URL)采集 完成后,执行将内容写入文件的操作

///

privatevoidwork_OnWorkItemEnd(stringcurWebTitle,stringcurWebContent,stringcurUrl)

{

//将采集的内容写入文件流

byte[]byteWebContent=Encoding.UTF8.GetBytes(curWebContent);

如果(_task.IsSaveOnlyFile)

{

//如果当前内容标题为空,可能会被分页

if(!string.IsNullOrEmpty(curWebTitle))

{

byte[]byteWebTitle=Encoding.UTF8.GetBytes(curWebTitle);

_curSavaFile.Write(byteWebTitle,0,byteWebTitle.Length);

}

_curSavaFile.Write(byteWebContent,0,byteWebContent.Length);

}

别的

{

using(FileStreamcurSavaFile2=newFileStream("{0}{1}.txt".FormatWith(_task.SavePath,curWebTitle),FileMode.OpenOrCreate,FileAccess.ReadWrite))

{

curSavaFile2.Write(byteWebContent,0,byteWebContent.Length);

}

}

UpdateWorkMessage("\nAlready 采集: {0}, URL: {1}".FormatWith(curWebTitle,curUrl));

Application.DoEvents();

}

其他及更多请下载源码查看

其他

运行程序下载:

源码下载请到开源地址下载

开源地址:

如果不明白github是如何下载源码的,请看文章:

对采集感兴趣的朋友,可以一起维护和贡献代码,让大家轻松共享同一个采集框架。

QQ群:9524888

欢迎大家进群交流分享采集任务规则,讨论技术,讨论生活... 查看全部

网站程序自带的采集器采集文章(科技业的员工到底有多年轻(1),那么标识可以是(1))

第一页的logo,如标题“科技行业的员工有多年轻(1)),那么logo就可以(1)

保存路线

采集内容的存储目录

分页

表示采集的文章数据是分页的,然后程序会根据设置的规则判断是否是分页的章节,如果是,则不重复添加标题。

例如

科技行业的员工有多年轻(1)

科技行业的员工有多年轻(2)

科技行业的员工有多年轻(3)

所以在采集的过程中,只会写一个标题【科技行业的员工有多年轻】

另存为文件

如果选中,来自 采集 的所有内容都将写入文件

开始

启动采集并保存内容

测试

在消息框中显示采集的效果

格式化表单

左边是匹配的字符,后面是要替换的字符。

当程序运行时,将第二行(如果有两行)中的字符的副本转换为大写并组合在一起进行格式化。

换行标签、空白标签、缩进标签

您可以输入包括正则在内的字符进行匹配

章节标题

{0} 表示采集 的编号(采集 将1) 添加到地址中,{1} 表示采集 的标题。

无障碍

输入字符可以大小写转换

编写新规则

编写采集 规则需要一定的正则表达式知识。如果您不明白,请阅读此页面:

任务以xml文件的形式保存,文件名格式为:任务名称-网站 name.xml

在任何任务状态下,您只需要修改任务名称,或网站名称,然后单击保存任务即可创建新任务。

如果名称相同,会提示是否覆盖。

这里以博客园新闻为例

博客花园新闻是一个列表式的采集任务-一个页面可以匹配得到多个页面地址

使用firebug或其他前端调试工具,可以轻松获得采集特性

例如下图

点击红框【点击查看页面要素】,点击页面【创业公司如何评估-如何衡量公司潜力】的位置。

你可以找到html代码

这样就可以得到内容页面的链接特征

创业公司如何估值——衡量公司潜力的方法

然后你需要观察这个识别是否是唯一的特征,也就是这个特征匹配的就是你所期望的。否则,需要添加更多限制性功能。

将特征编写为匹配的正则表达式

来源描述

该解决方案包括 3 个项目

Forms 是一个窗口程序

框架是一个采集程序

Helper 是一个辅助程序

考虑到以后会加入不同的采集任务,采用MDI形式。

Config目录是默认配置

FrmFormatConfig 是内容格式化配置表单

FrmGatherWorker 是 采集 工作表

MDIParentMain 是表单容器

config 是一个内容格式化配置实体类

Task是采集任务规则实体类

工人是 采集 工作班级

Worker采集Work 类描述

让我们来看看3个主要事件

///

///错误触发事件,传入参数引起的异常对象,错误类型,当前工作URL

///

publiceventActionstring>OnError;

///

///工作结束触发事件

///

publiceventActionOnWorkEnd;

///

///Once/Address 采集 完成触发事件,传入参数采集 content title, content, URL

///

publiceventActionOnWorkItemEnd;

创建对象

Workerwork=newWorker(_httpRequest,_config,_task);

work.OnError+=w_OnError;

work.OnWorkItemEnd+=work_OnWorkItemEnd;

work.OnWorkEnd+=work_OnWorkEnd;

定义内容处理

///

///Once(一个URL)采集 完成后,执行将内容写入文件的操作

///

privatevoidwork_OnWorkItemEnd(stringcurWebTitle,stringcurWebContent,stringcurUrl)

{

//将采集的内容写入文件流

byte[]byteWebContent=Encoding.UTF8.GetBytes(curWebContent);

如果(_task.IsSaveOnlyFile)

{

//如果当前内容标题为空,可能会被分页

if(!string.IsNullOrEmpty(curWebTitle))

{

byte[]byteWebTitle=Encoding.UTF8.GetBytes(curWebTitle);

_curSavaFile.Write(byteWebTitle,0,byteWebTitle.Length);

}

_curSavaFile.Write(byteWebContent,0,byteWebContent.Length);

}

别的

{

using(FileStreamcurSavaFile2=newFileStream("{0}{1}.txt".FormatWith(_task.SavePath,curWebTitle),FileMode.OpenOrCreate,FileAccess.ReadWrite))

{

curSavaFile2.Write(byteWebContent,0,byteWebContent.Length);

}

}

UpdateWorkMessage("\nAlready 采集: {0}, URL: {1}".FormatWith(curWebTitle,curUrl));

Application.DoEvents();

}

其他及更多请下载源码查看

其他

运行程序下载:

源码下载请到开源地址下载

开源地址:

如果不明白github是如何下载源码的,请看文章:

对采集感兴趣的朋友,可以一起维护和贡献代码,让大家轻松共享同一个采集框架。

QQ群:9524888

欢迎大家进群交流分享采集任务规则,讨论技术,讨论生活...

网站程序自带的采集器采集文章(python爬虫数据的第一步必须分析目标网站的技术与目标数据)

采集交流 • 优采云 发表了文章 • 0 个评论 • 138 次浏览 • 2021-11-03 02:02

这几年python的火爆异常火爆!在大学期间,我也做了很多深入的学习。毕业后,我尝试使用python作为我的职业方向。虽然我没有如愿以偿地成为一名python工程师,但我对python的掌握也让我现在的工作发展和职业发展更加出色。便利。本文文章主要与大家分享我自己在python爬虫方面的收获和感悟。

Python爬虫是python应用最熟悉的方式。因为python有丰富的第三方开发库,所以可以做很多工作:比如web开发(django)、应用开发(tkinter、wxpython、qt)、数据统计与计算(numpy)、图形图像处理、深度学习,人工智能等。我一般用python爬虫(结合tkinter开发爬虫应用),用django开发一些小个体网站。django框架可以根据实体类自动生成管理终端,大大提高了系统的开发效率,有兴趣的朋友可以试试。

一个成功的爬虫需要对应一个标准化的网站。爬虫主要是为了方便我们获取数据。如果目标系统开发不规范、不规范,很难用爬虫定制一套规则来爬取,而且爬虫基本上是定制的,需要针对不同的系统进行调整。

爬虫爬取数据的第一步,必须分析目标网站的技术和网站的数据结构(通过前端源码)。您可以使用 chrome 浏览器。目前python爬虫主要会面对三种网站:

1. 前后端分离网站

前端通过参数访问接口,后端返回json数据。对于这种网站,python可以模拟浏览器前端,发送参数然后接收数据,完成爬虫数据目标

2. 静态网站

通过python的第三方库(requests、urllib)下载源码,通过xpath和regular进行数据匹配

3.动态网站

如果采用第二种方法,下载的源代码只是简单的html,源代码中没有数据,因为这样的动态网站需要在源代码中有数据之前加载js。对于这种类型的 网站 ,可以使用自动化测试工具 selenium

爬虫步骤:

分析网站技术和目标数据的结构。根据第一步,分析结构,选择相应的技术策略进行数据爬取,提高性能,提高操作舒适度(结合客户端技术,为爬虫定制接口)根据需要清理数据 数据存储,存储在数据库中,文件等

防采摘机制:

1. 当系统判断属于同一个ip的客户端有多次访问而没有中断时,会拒绝访问这个ip

解决方案:动态代理,不断改变ip访问目标系统,或者从免费ip代理网站爬取ip,创建ip池,如果目标数据量不大,可以降低访问速度避免Reverse

2. 目标系统需要注册登录才能访问

解决方法:使用python的第三方库(Faker)生成假登录名、密码、个人资料,用于自动注册登录

3. 需要对目标系统的目标数据页面的链接进行处理,然后才能进入目标数据页面进行访问

解决方法:无法正常访问目标网站的目标数据页链接。需要研究页面中的js脚本,对链接进行处理。我个人用搜狗浏览器爬取微信账号文章,遇到过这个问题。爬取的文章链接需要通过js脚本拼接才能得到正确的链接地址

从哪里获取目标数据:

通过xpath获取数据的位置,可以使用chrome浏览器调试功能通过正则匹配获取对应数据的xpath路径

Python爬虫第三方常用库:

urllib/requests 请求库

Faker 生成假数据

UserAgent 生成假数据头

etree、beautsoup 匹配数据

json 处理json数据

re 正则库

selenium 自动化测试库

sqlite3 数据库 python3自带

抓取静态网页数据:

import requests

from fake_useragent import UserAgent #提供假的请求头

from lxml import etree # 匹配数据

#爬取目标页面的url

url='http://***ip****:8085/pricePublic/house/public/index'

headers= {'User-Agent':str(UserAgent().random)}

response=requests.get(url,headers=headers)

# 获得网页源码

content=response.text

html=etree.HTML(content)

#使用xpath查找对应标签处的元素值,pageNum此处爬取对应页面的页码

pageNum=html.xpath('//*[@id="dec"]/div[2]/div/span[1]/text()')

爬取前后端分离系统的数据:

import json

import requests

#获取返回的response

url='http://***ip***/FindById/22'

response=requests.get(url)

#通过json库解析json,获得返回的数据

DataNode = json.loads(response.text).get('returndata').get('data')[0]

爬取动态数据:

以下代码示例使用谷歌浏览器,使用 selenium 库,并将浏览器设置为无头模式。爬虫会配合浏览器在后台模拟人工操作。爬虫会根据代码中定义的xpath地址,在浏览器中找到对应的位置。操作,使用selenium抓取数据时,需要安装相应版本的浏览器驱动

import requests

from faker import Faker

from fake_useragent import UserAgent

from lxml import etree

url='http://***ip***/FindById/22'

#通过faker库获得假email和电话号码

fake=Fakeer('zh_CN')

email=fake.email()

tel=fake.phone_number()

data={

"email":email

}

#使用requests库发送post请求

response=requests.post(url,data,headers=headers)

code=response.status_code

content=response.text

#获得返回的cookies并转换为字典形式

cookies = requests.utils.dict_from_cookiejar(response.cookies)

#请求的时候带上cookies

response=requests.get(url,headers=headers,cookies=cookies)

作为合法公民,爬虫只是一种技术。当我们使用它来抓取目标数据时,我们必须遵守一定的规则。每个网站的根目录下都会有robots.txt(爬虫协议)文件。,其中规定那些网页可以被访问,用于抓取公共信息和数据,并且不得对目标系统造成严重损害。因此,我们呼吁大家在使用各种技术开展工作的过程中要遵守各种技术。规章制度规范,共同为你我他创造文明的网络环境! 查看全部

网站程序自带的采集器采集文章(python爬虫数据的第一步必须分析目标网站的技术与目标数据)

这几年python的火爆异常火爆!在大学期间,我也做了很多深入的学习。毕业后,我尝试使用python作为我的职业方向。虽然我没有如愿以偿地成为一名python工程师,但我对python的掌握也让我现在的工作发展和职业发展更加出色。便利。本文文章主要与大家分享我自己在python爬虫方面的收获和感悟。

Python爬虫是python应用最熟悉的方式。因为python有丰富的第三方开发库,所以可以做很多工作:比如web开发(django)、应用开发(tkinter、wxpython、qt)、数据统计与计算(numpy)、图形图像处理、深度学习,人工智能等。我一般用python爬虫(结合tkinter开发爬虫应用),用django开发一些小个体网站。django框架可以根据实体类自动生成管理终端,大大提高了系统的开发效率,有兴趣的朋友可以试试。

一个成功的爬虫需要对应一个标准化的网站。爬虫主要是为了方便我们获取数据。如果目标系统开发不规范、不规范,很难用爬虫定制一套规则来爬取,而且爬虫基本上是定制的,需要针对不同的系统进行调整。

爬虫爬取数据的第一步,必须分析目标网站的技术和网站的数据结构(通过前端源码)。您可以使用 chrome 浏览器。目前python爬虫主要会面对三种网站:

1. 前后端分离网站

前端通过参数访问接口,后端返回json数据。对于这种网站,python可以模拟浏览器前端,发送参数然后接收数据,完成爬虫数据目标

2. 静态网站

通过python的第三方库(requests、urllib)下载源码,通过xpath和regular进行数据匹配

3.动态网站

如果采用第二种方法,下载的源代码只是简单的html,源代码中没有数据,因为这样的动态网站需要在源代码中有数据之前加载js。对于这种类型的 网站 ,可以使用自动化测试工具 selenium

爬虫步骤:

分析网站技术和目标数据的结构。根据第一步,分析结构,选择相应的技术策略进行数据爬取,提高性能,提高操作舒适度(结合客户端技术,为爬虫定制接口)根据需要清理数据 数据存储,存储在数据库中,文件等

防采摘机制:

1. 当系统判断属于同一个ip的客户端有多次访问而没有中断时,会拒绝访问这个ip

解决方案:动态代理,不断改变ip访问目标系统,或者从免费ip代理网站爬取ip,创建ip池,如果目标数据量不大,可以降低访问速度避免Reverse

2. 目标系统需要注册登录才能访问

解决方法:使用python的第三方库(Faker)生成假登录名、密码、个人资料,用于自动注册登录

3. 需要对目标系统的目标数据页面的链接进行处理,然后才能进入目标数据页面进行访问

解决方法:无法正常访问目标网站的目标数据页链接。需要研究页面中的js脚本,对链接进行处理。我个人用搜狗浏览器爬取微信账号文章,遇到过这个问题。爬取的文章链接需要通过js脚本拼接才能得到正确的链接地址

从哪里获取目标数据:

通过xpath获取数据的位置,可以使用chrome浏览器调试功能通过正则匹配获取对应数据的xpath路径

Python爬虫第三方常用库:

urllib/requests 请求库

Faker 生成假数据

UserAgent 生成假数据头

etree、beautsoup 匹配数据

json 处理json数据

re 正则库

selenium 自动化测试库

sqlite3 数据库 python3自带

抓取静态网页数据:

import requests

from fake_useragent import UserAgent #提供假的请求头

from lxml import etree # 匹配数据

#爬取目标页面的url

url='http://***ip****:8085/pricePublic/house/public/index'

headers= {'User-Agent':str(UserAgent().random)}

response=requests.get(url,headers=headers)

# 获得网页源码

content=response.text

html=etree.HTML(content)

#使用xpath查找对应标签处的元素值,pageNum此处爬取对应页面的页码

pageNum=html.xpath('//*[@id="dec"]/div[2]/div/span[1]/text()')

爬取前后端分离系统的数据:

import json

import requests

#获取返回的response

url='http://***ip***/FindById/22'

response=requests.get(url)

#通过json库解析json,获得返回的数据

DataNode = json.loads(response.text).get('returndata').get('data')[0]

爬取动态数据:

以下代码示例使用谷歌浏览器,使用 selenium 库,并将浏览器设置为无头模式。爬虫会配合浏览器在后台模拟人工操作。爬虫会根据代码中定义的xpath地址,在浏览器中找到对应的位置。操作,使用selenium抓取数据时,需要安装相应版本的浏览器驱动

import requests

from faker import Faker

from fake_useragent import UserAgent

from lxml import etree

url='http://***ip***/FindById/22'

#通过faker库获得假email和电话号码

fake=Fakeer('zh_CN')

email=fake.email()

tel=fake.phone_number()

data={

"email":email

}

#使用requests库发送post请求

response=requests.post(url,data,headers=headers)

code=response.status_code

content=response.text

#获得返回的cookies并转换为字典形式

cookies = requests.utils.dict_from_cookiejar(response.cookies)

#请求的时候带上cookies

response=requests.get(url,headers=headers,cookies=cookies)

作为合法公民,爬虫只是一种技术。当我们使用它来抓取目标数据时,我们必须遵守一定的规则。每个网站的根目录下都会有robots.txt(爬虫协议)文件。,其中规定那些网页可以被访问,用于抓取公共信息和数据,并且不得对目标系统造成严重损害。因此,我们呼吁大家在使用各种技术开展工作的过程中要遵守各种技术。规章制度规范,共同为你我他创造文明的网络环境!

网站程序自带的采集器采集文章(怎么通过nginx来屏蔽网络爬虫的危害,nginx服务器屏蔽)

采集交流 • 优采云 发表了文章 • 0 个评论 • 130 次浏览 • 2021-11-02 12:08

2019-3-27 10:6:13 网络爬虫对服务器的危害,nginx服务器屏蔽网络爬虫采集器

网络上有很多恶心的鬼程序爬虫,日日夜夜采集他人网站,把别人的劳动成果当成自己的。想到这些不受欢迎的爬虫,相信很多站长都心痒痒的,但也无计可施。

网络爬虫的缺点:

采集器频繁的爬取影响了网站的正常运行,特别是对于低配置的服务器,那个可怜的虚拟空间的流量可能很快就会耗尽。网站这种经常打不开或者打开很慢的类型,除了本身服务器配置不好,往往是网络采集器造成的。

每一个网站通常都会遇到很多非搜索引擎爬虫。这些爬虫大多用于内容采集或初学者编写的内容。它们与搜索引擎爬虫不同,没有频率。控制往往会消耗大量服务器资源,造成带宽浪费。下面介绍如何通过nginx拦截网络爬虫。

经常在网上看到seo或者站长朋友使用robots.txt文件的User-Agent配合Disallow命令实现拦截。指导某人在网站的根目录下创建robots.txt文件,并写了一堆指令禁止不受欢迎的爬虫。我满心欢喜,以为屏蔽效果就达到了,目的就达到了。事实上,事实并非如此。首先我们要明白,robots.txt只是网络机器人(或蜘蛛)的爬行条约。请注意,这只是一项条约。欢迎哪些爬虫爬取?

此类条约实际上不具有约束力。爬虫是否遵守这些条约是另一回事。对于爬虫中的绅士(常规搜索引擎)来说真的很有效。他们来到网站之后,通常会检查机器人。.txt 文件,老老实实按照站长的规则抓取网页,但是对那些采集 爬虫有效吗?可以肯定的是:无效,他们完全忽略robots.txt,他们只需要网站的内容,而且,当你看到那些明确指定为不可抓取的网页时,你会加倍努力采集 既然不允许爬行,也许有什么好东西?

所以robots.txt不是万能钥匙,可以防君子,防小人。但也不是不可能,作为领先的web服务器:Apache和nginx其实是有屏蔽策略的,关键是能不能用。下面是我之前单位使用的一个禁止策略,可以拦截采集的一些程序。现在把代码放在下面,操作方法:找到nginx.conf配置文件,把下面的代码放到服务器中。

1

2

3

4

#禁止爬虫工具和无关搜索引擎

if($http_user_agent~*(Scrapy|Curl|HttpClient|python|phantomjs|EtaoSpider|HuihuiSpider|WochachaSpider|GwdangSpider|YYSpider|MJ12bot|^$)){

返回403;

}

结果是这样的:

1

2

3

4

5

6

7

8

9

10

服务器

{

#禁止爬虫工具和无关搜索引擎

if($http_user_agent~*(Scrapy|Curl|HttpClient|python|phantomjs|EtaoSpider|HuihuiSpider|WochachaSpider|GwdangSpider|YYSpider|MJ12bot|^$)){

返回403;

}

#下面是其他配置项

}

保存配置文件并使用命令行:

1

systemctlrestartnginx

重启nginx服务生效。

其他方法:

1. 基于程序本身防止爬行:作为爬虫程序,爬行行为就是爬取页面的源文件,比如爬取一个静态页面的html代码,可以用jquery模仿写html,这种方法伪装页面很难被抓取,但是这种方法对程序员的要求很高。

2.基于iptables和shell脚本:可以定义nginx的access.log的策略。比如定义1分钟并发连接数超过30个ips就是非法的。如果ip不在白名单中,加iptables策略块 当然,这种的缺点是会有“伤害”。细粒度的策略越小,“伤害”就越大。粒度越大,效果越差。此外,还有类似的第三方工具fail2ban。做过滤器和演员来记录或阻止一些有害操作的 ip。但是,很难准确拒绝特定爬虫地址(如网易、有道)的抓取行为,因为您无法准确知道这些特定的爬虫IP地址(如网易、有道),下面是我的定位方法,但是发现屏蔽错误是ip库不准确造成的。注意:不推荐使用封ip入口的方法。当iptables列表长度为65535时,会满,服务器崩溃。

这篇文章是一个灵感,它只能处理一般的网络采集程序。我们与网络爬虫的斗争才刚刚开始。更多信息请关注数据。

标签:什么是网络爬虫以及如何防止网络爬虫被非搜索引擎爬虫禁止采集 程序发布:云计算数据栏 | 类别:日常维护 | 评论:0 | 浏览:

数据条-为您提供免备案的虚拟空间,国外主机,独立IP空间,高速稳定,支持包月付款。高防云服务器月付98元起,美国VPS月付98元起,香港云服务器月付55元起,高防CDN月付298元起,香港物理服务器月付起698元,韩国服务器租用月付98元起,最低动态IP为78/月,省去备案的麻烦,数据栏带你进入免备案时代。

留言:

◎欢迎参与讨论,请在此发表您的看法,交流您的看法。

搜索

产品购买入口

网站类别

文章存档

链接

车站标志入口

Powered By 站长信息中心 站长信息中心为您提供各类站长信息、站长信息,我们的宗旨是为广大站长服务。您将在这里获得最新、最全面、最专业的行业资讯和网站施工技术文档! 查看全部

网站程序自带的采集器采集文章(怎么通过nginx来屏蔽网络爬虫的危害,nginx服务器屏蔽)

2019-3-27 10:6:13 网络爬虫对服务器的危害,nginx服务器屏蔽网络爬虫采集器

网络上有很多恶心的鬼程序爬虫,日日夜夜采集他人网站,把别人的劳动成果当成自己的。想到这些不受欢迎的爬虫,相信很多站长都心痒痒的,但也无计可施。

网络爬虫的缺点:

采集器频繁的爬取影响了网站的正常运行,特别是对于低配置的服务器,那个可怜的虚拟空间的流量可能很快就会耗尽。网站这种经常打不开或者打开很慢的类型,除了本身服务器配置不好,往往是网络采集器造成的。

每一个网站通常都会遇到很多非搜索引擎爬虫。这些爬虫大多用于内容采集或初学者编写的内容。它们与搜索引擎爬虫不同,没有频率。控制往往会消耗大量服务器资源,造成带宽浪费。下面介绍如何通过nginx拦截网络爬虫。

经常在网上看到seo或者站长朋友使用robots.txt文件的User-Agent配合Disallow命令实现拦截。指导某人在网站的根目录下创建robots.txt文件,并写了一堆指令禁止不受欢迎的爬虫。我满心欢喜,以为屏蔽效果就达到了,目的就达到了。事实上,事实并非如此。首先我们要明白,robots.txt只是网络机器人(或蜘蛛)的爬行条约。请注意,这只是一项条约。欢迎哪些爬虫爬取?

此类条约实际上不具有约束力。爬虫是否遵守这些条约是另一回事。对于爬虫中的绅士(常规搜索引擎)来说真的很有效。他们来到网站之后,通常会检查机器人。.txt 文件,老老实实按照站长的规则抓取网页,但是对那些采集 爬虫有效吗?可以肯定的是:无效,他们完全忽略robots.txt,他们只需要网站的内容,而且,当你看到那些明确指定为不可抓取的网页时,你会加倍努力采集 既然不允许爬行,也许有什么好东西?

所以robots.txt不是万能钥匙,可以防君子,防小人。但也不是不可能,作为领先的web服务器:Apache和nginx其实是有屏蔽策略的,关键是能不能用。下面是我之前单位使用的一个禁止策略,可以拦截采集的一些程序。现在把代码放在下面,操作方法:找到nginx.conf配置文件,把下面的代码放到服务器中。

1

2

3

4

#禁止爬虫工具和无关搜索引擎

if($http_user_agent~*(Scrapy|Curl|HttpClient|python|phantomjs|EtaoSpider|HuihuiSpider|WochachaSpider|GwdangSpider|YYSpider|MJ12bot|^$)){

返回403;

}

结果是这样的:

1

2

3

4

5

6

7

8

9

10

服务器

{

#禁止爬虫工具和无关搜索引擎

if($http_user_agent~*(Scrapy|Curl|HttpClient|python|phantomjs|EtaoSpider|HuihuiSpider|WochachaSpider|GwdangSpider|YYSpider|MJ12bot|^$)){

返回403;

}

#下面是其他配置项

}

保存配置文件并使用命令行:

1

systemctlrestartnginx

重启nginx服务生效。

其他方法:

1. 基于程序本身防止爬行:作为爬虫程序,爬行行为就是爬取页面的源文件,比如爬取一个静态页面的html代码,可以用jquery模仿写html,这种方法伪装页面很难被抓取,但是这种方法对程序员的要求很高。

2.基于iptables和shell脚本:可以定义nginx的access.log的策略。比如定义1分钟并发连接数超过30个ips就是非法的。如果ip不在白名单中,加iptables策略块 当然,这种的缺点是会有“伤害”。细粒度的策略越小,“伤害”就越大。粒度越大,效果越差。此外,还有类似的第三方工具fail2ban。做过滤器和演员来记录或阻止一些有害操作的 ip。但是,很难准确拒绝特定爬虫地址(如网易、有道)的抓取行为,因为您无法准确知道这些特定的爬虫IP地址(如网易、有道),下面是我的定位方法,但是发现屏蔽错误是ip库不准确造成的。注意:不推荐使用封ip入口的方法。当iptables列表长度为65535时,会满,服务器崩溃。

这篇文章是一个灵感,它只能处理一般的网络采集程序。我们与网络爬虫的斗争才刚刚开始。更多信息请关注数据。

标签:什么是网络爬虫以及如何防止网络爬虫被非搜索引擎爬虫禁止采集 程序发布:云计算数据栏 | 类别:日常维护 | 评论:0 | 浏览:

数据条-为您提供免备案的虚拟空间,国外主机,独立IP空间,高速稳定,支持包月付款。高防云服务器月付98元起,美国VPS月付98元起,香港云服务器月付55元起,高防CDN月付298元起,香港物理服务器月付起698元,韩国服务器租用月付98元起,最低动态IP为78/月,省去备案的麻烦,数据栏带你进入免备案时代。

留言:

◎欢迎参与讨论,请在此发表您的看法,交流您的看法。

搜索

产品购买入口

网站类别

文章存档

链接

车站标志入口

Powered By 站长信息中心 站长信息中心为您提供各类站长信息、站长信息,我们的宗旨是为广大站长服务。您将在这里获得最新、最全面、最专业的行业资讯和网站施工技术文档!

网站程序自带的采集器采集文章(3.PDO类App\Handle.json\PdoHandle.php我们使用PDO来操作)

采集交流 • 优采云 发表了文章 • 0 个评论 • 111 次浏览 • 2021-10-31 04:03

安装方法:

composer require guzzlehttp/guzzle:~6.0

或者:

加入 composer.json

"require": {

"guzzlehttp/guzzle": "~6.0"

}

}

2. 查询列表

QueryList 是基于 phpQuery 的通用 PHP 列表采集 类。多亏了 phpQuery,使用 QueryList 几乎没有学习成本。只要您了解 CSS3 选择器,就可以轻松使用 QueryList。它让 PHP 做到这一点。 采集就像jQuery选择元素一样简单。 QueryList 的几个特点:

易学:只有一个核心API好用:使用jQuery选择器选择页面元素,带过滤功能,可以过滤掉无用的内容,支持无限层级的嵌套采集采集 结果是直接的采集规则以列表的形式返回,以便支持扩展

我们可以用它来过滤html内容

安装方法:

composer require jaeger/querylist:V3.2.1

采集案例

让我们以 LearnKu 社区为例。我们将采集社区的帖子信息保存在一个文件和一个mysql数据库中。

1.安装依赖

在命令行输入以下命令

composer init

引入依赖

{

"require": {

"guzzlehttp/guzzle": "~6.0@dev",

"jaeger/querylist": "V3.2.1"

},

"autoload": {

"psr-4": {

"App\\": "app/"

}

}

}

安装依赖

composer install

2.采集班级

app\Handle\ClientHandle.php

<p> 查看全部

网站程序自带的采集器采集文章(3.PDO类App\Handle.json\PdoHandle.php我们使用PDO来操作)

安装方法:

composer require guzzlehttp/guzzle:~6.0

或者:

加入 composer.json

"require": {

"guzzlehttp/guzzle": "~6.0"

}

}

2. 查询列表

QueryList 是基于 phpQuery 的通用 PHP 列表采集 类。多亏了 phpQuery,使用 QueryList 几乎没有学习成本。只要您了解 CSS3 选择器,就可以轻松使用 QueryList。它让 PHP 做到这一点。 采集就像jQuery选择元素一样简单。 QueryList 的几个特点:

易学:只有一个核心API好用:使用jQuery选择器选择页面元素,带过滤功能,可以过滤掉无用的内容,支持无限层级的嵌套采集采集 结果是直接的采集规则以列表的形式返回,以便支持扩展

我们可以用它来过滤html内容

安装方法:

composer require jaeger/querylist:V3.2.1

采集案例

让我们以 LearnKu 社区为例。我们将采集社区的帖子信息保存在一个文件和一个mysql数据库中。

1.安装依赖

在命令行输入以下命令

composer init

引入依赖

{

"require": {

"guzzlehttp/guzzle": "~6.0@dev",

"jaeger/querylist": "V3.2.1"

},

"autoload": {

"psr-4": {

"App\\": "app/"

}

}

}

安装依赖

composer install

2.采集班级

app\Handle\ClientHandle.php

<p>

网站程序自带的采集器采集文章(拼多多的朋友想做竞品分析,找我帮忙用工具采集数据)

采集交流 • 优采云 发表了文章 • 0 个评论 • 216 次浏览 • 2021-11-24 08:01

不知道你有没有IT背景。如果没有,建议使用博威小邦软件机器人。数据采集是这个工具的基本功能之一。不需要IT背景,只需要基本的电脑操作,你懂的。采集 数据的目标软件、目标网页的登录、新增、复制粘贴等基本操作都可以。

采集 功能包括来自电脑端软件、网页采集表单数据、详情页字段、图片;可以设置各种条件采集,采集范围和时间采集,,采集完成输出你想要的Excel表格结构数据。

本软件主要是采集界面上的可见数据,包括一些网站限制复制粘贴数据。比如拼多多页面上的文字是不能用鼠标复制粘贴的。但是你可以用采集这个东西,只要显示在界面上,采集都不是问题。一个朋友在坑里想做竞品分析,求我帮忙用采集Data 这个工具是我叔推荐的软件机器人

像他们的电商行业的大企业一般都会使用各种专业的爬虫工具来获取数据进行分析和辅助营销决策,但是像我朋友这样的小企业一般没有那个投资预算和专业背景。因此,我向他推荐的数据工具“博威小邦软件机器人”配置相对简单。像他这样的电脑水平,完全IT外行,他可以轻松配置一个采集工具,采集拼多多,电商平台上所有可见的产品数据(价格、销量、规格) 、详细的文案、货架时间甚至买家评论等)

但我认为有一点陷阱。本工具不支持苹果系统,只能在Win7和Win10上运行。如果你的系统支持它,我建议你试试这个工具。 查看全部

网站程序自带的采集器采集文章(拼多多的朋友想做竞品分析,找我帮忙用工具采集数据)

不知道你有没有IT背景。如果没有,建议使用博威小邦软件机器人。数据采集是这个工具的基本功能之一。不需要IT背景,只需要基本的电脑操作,你懂的。采集 数据的目标软件、目标网页的登录、新增、复制粘贴等基本操作都可以。

采集 功能包括来自电脑端软件、网页采集表单数据、详情页字段、图片;可以设置各种条件采集,采集范围和时间采集,,采集完成输出你想要的Excel表格结构数据。

本软件主要是采集界面上的可见数据,包括一些网站限制复制粘贴数据。比如拼多多页面上的文字是不能用鼠标复制粘贴的。但是你可以用采集这个东西,只要显示在界面上,采集都不是问题。一个朋友在坑里想做竞品分析,求我帮忙用采集Data 这个工具是我叔推荐的软件机器人

像他们的电商行业的大企业一般都会使用各种专业的爬虫工具来获取数据进行分析和辅助营销决策,但是像我朋友这样的小企业一般没有那个投资预算和专业背景。因此,我向他推荐的数据工具“博威小邦软件机器人”配置相对简单。像他这样的电脑水平,完全IT外行,他可以轻松配置一个采集工具,采集拼多多,电商平台上所有可见的产品数据(价格、销量、规格) 、详细的文案、货架时间甚至买家评论等)

但我认为有一点陷阱。本工具不支持苹果系统,只能在Win7和Win10上运行。如果你的系统支持它,我建议你试试这个工具。

网站程序自带的采集器采集文章( 关于网页采集器的使用方法,以及我是如何通过本篇把网站做到权五的 )

采集交流 • 优采云 发表了文章 • 0 个评论 • 137 次浏览 • 2021-11-24 08:00

关于网页采集器的使用方法,以及我是如何通过本篇把网站做到权五的

)

关于网页采集器的使用,以及我是如何使用采集器制作网站全武的。通过这篇文章,我将与大家分享采集器的一些使用技巧。看完你就会明白,把网站做到五点并不难!作为一个站长,我现在手头有将近一千个网站。我需要每天维护我的网站。最重要的是要填写网站的内容,手动肯定是做不到的。这个工作做完了,所以我总是用免费的采集器到文章采集,填上我自己的网站的内容。接下来给大家讲讲采集器怎么用好,以及一些增加网站权重的小方法。

首先,我告诉你为什么我们使用采集器 而不是自己创建网站 内容。目前,大多数站长和企业网站管理员需要不止一个网站日常维护,比如上万个域名。那么这么多网站的内容是哪里来的呢?你只能用采集的内容填写你自己的网站。

那我就告诉你一个采集器的选择。市场上有采集器几千万,大家都说好。小编总结为fit最好,必须满足以下几点:第一,成本问题,现在做站难,大部分站长都很难维护,小编认为免费是最好的!第二点是操作问题。毕竟大部分站长都不知道怎么写代码和采集规则,所以操作一定要非常简单,让一个什么都不知道的站长也能正常使用。第三点是实际问题。简单设置之后,最好挂断,不管什么样的,让他不停的接,不停的提供文章给网站。第四点,采集的来源一定要丰富。采集 的多平台资源非常重要。这样可以防止文章被同质化,也可以针对不同的搜索做。适用于收录。只要能同时满足这几点,就适合我们。小编一直通过免费采集器文章采集做到这一点,不仅可以满足日常网站 采集的数量需求,而且操作非常简单,简单配置后,放在那里挂断采集。

那我是怎么用采集来组成网站的呢?很多站长都说采集站大部分都是垃圾站。那是因为你根本没有做。很多人说采集站很容易被搜索引擎攻击。这就是为什么你不能这样做!说说我的方法吧。采集的来源肯定更多。比如百度,我会多一些采集一些标题文章。原因很简单。头条封杀了百度。头条蜘蛛,那么头条文章很可能百度没有收录,所以采集过去文章的内容质量会更好。第二点,采集一定要针对采集,比如你的网站是装修网,那么你的采集< @文章和标题一定要一致你对网站的定位,不想穿,在旅游网做装饰采集信息。第三点是采集中的文章必须处理,必须是伪原创!因为蜘蛛在爬取过程中会识别你的文章内容。如果重复率太高,就会判定你是采集网站的内容,抄袭别人的内容,所以得不到收录和排名。最后,新生成的文章链接一定要及时主动推送给搜索引擎,这样才能保证你的网站更多收录,也让搜索引擎知道你的更新频率!不想穿,在旅游网做装饰采集信息。第三点是采集中的文章必须处理,必须是伪原创!因为蜘蛛在爬取过程中会识别你的文章内容。如果重复率太高,就会判定你是采集网站的内容,抄袭别人的内容,所以得不到收录和排名。最后,新生成的文章链接一定要及时主动推送给搜索引擎,这样才能保证你的网站更多收录,也让搜索引擎知道你的更新频率!不想穿,在旅游网做装饰采集信息。第三点是采集中的文章必须处理,必须是伪原创!因为蜘蛛在爬取过程中会识别你的文章内容。如果重复率太高,就会判定你是采集网站的内容,抄袭别人的内容,所以得不到收录和排名。最后,新生成的文章链接一定要及时主动推送给搜索引擎,这样才能保证你的网站更多收录,也让搜索引擎知道你的更新频率!并且必须是 伪原创!因为蜘蛛在爬取过程中会识别你的文章内容。如果重复率太高,就会判定你是采集网站的内容,抄袭别人的内容,所以得不到收录和排名。最后,新生成的文章链接一定要及时主动推送给搜索引擎,这样才能保证你的网站更多收录,也让搜索引擎知道你的更新频率!并且必须是 伪原创!因为蜘蛛在爬取过程中会识别你的文章内容。如果重复率太高,就会判定你是采集网站的内容,抄袭别人的内容,所以得不到收录和排名。最后,新生成的文章链接一定要及时主动推送给搜索引擎,这样才能保证你的网站更多收录,也让搜索引擎知道你的更新频率!

其实想要网站做好,还有很多维度需要解决。今天小编主要讲和采集分享一些经验。做网站优化,我们必须考虑到每一个维度。编辑器可以做一个网站从零到五次方,不仅采集做得好,从一开始的域名服务器选择,再到后期的站点优化和异地优化,我研究点点滴滴,各方面都做好。我会陆续和大家分享更多的SEO相关知识。网站管理员可以喜欢、关注和添加到采集夹。同时也可以在评论区分享自己的一些SEO心得,让大家一起学习成长!

查看全部

网站程序自带的采集器采集文章(

关于网页采集器的使用方法,以及我是如何通过本篇把网站做到权五的

)

关于网页采集器的使用,以及我是如何使用采集器制作网站全武的。通过这篇文章,我将与大家分享采集器的一些使用技巧。看完你就会明白,把网站做到五点并不难!作为一个站长,我现在手头有将近一千个网站。我需要每天维护我的网站。最重要的是要填写网站的内容,手动肯定是做不到的。这个工作做完了,所以我总是用免费的采集器到文章采集,填上我自己的网站的内容。接下来给大家讲讲采集器怎么用好,以及一些增加网站权重的小方法。

首先,我告诉你为什么我们使用采集器 而不是自己创建网站 内容。目前,大多数站长和企业网站管理员需要不止一个网站日常维护,比如上万个域名。那么这么多网站的内容是哪里来的呢?你只能用采集的内容填写你自己的网站。

那我就告诉你一个采集器的选择。市场上有采集器几千万,大家都说好。小编总结为fit最好,必须满足以下几点:第一,成本问题,现在做站难,大部分站长都很难维护,小编认为免费是最好的!第二点是操作问题。毕竟大部分站长都不知道怎么写代码和采集规则,所以操作一定要非常简单,让一个什么都不知道的站长也能正常使用。第三点是实际问题。简单设置之后,最好挂断,不管什么样的,让他不停的接,不停的提供文章给网站。第四点,采集的来源一定要丰富。采集 的多平台资源非常重要。这样可以防止文章被同质化,也可以针对不同的搜索做。适用于收录。只要能同时满足这几点,就适合我们。小编一直通过免费采集器文章采集做到这一点,不仅可以满足日常网站 采集的数量需求,而且操作非常简单,简单配置后,放在那里挂断采集。

那我是怎么用采集来组成网站的呢?很多站长都说采集站大部分都是垃圾站。那是因为你根本没有做。很多人说采集站很容易被搜索引擎攻击。这就是为什么你不能这样做!说说我的方法吧。采集的来源肯定更多。比如百度,我会多一些采集一些标题文章。原因很简单。头条封杀了百度。头条蜘蛛,那么头条文章很可能百度没有收录,所以采集过去文章的内容质量会更好。第二点,采集一定要针对采集,比如你的网站是装修网,那么你的采集< @文章和标题一定要一致你对网站的定位,不想穿,在旅游网做装饰采集信息。第三点是采集中的文章必须处理,必须是伪原创!因为蜘蛛在爬取过程中会识别你的文章内容。如果重复率太高,就会判定你是采集网站的内容,抄袭别人的内容,所以得不到收录和排名。最后,新生成的文章链接一定要及时主动推送给搜索引擎,这样才能保证你的网站更多收录,也让搜索引擎知道你的更新频率!不想穿,在旅游网做装饰采集信息。第三点是采集中的文章必须处理,必须是伪原创!因为蜘蛛在爬取过程中会识别你的文章内容。如果重复率太高,就会判定你是采集网站的内容,抄袭别人的内容,所以得不到收录和排名。最后,新生成的文章链接一定要及时主动推送给搜索引擎,这样才能保证你的网站更多收录,也让搜索引擎知道你的更新频率!不想穿,在旅游网做装饰采集信息。第三点是采集中的文章必须处理,必须是伪原创!因为蜘蛛在爬取过程中会识别你的文章内容。如果重复率太高,就会判定你是采集网站的内容,抄袭别人的内容,所以得不到收录和排名。最后,新生成的文章链接一定要及时主动推送给搜索引擎,这样才能保证你的网站更多收录,也让搜索引擎知道你的更新频率!并且必须是 伪原创!因为蜘蛛在爬取过程中会识别你的文章内容。如果重复率太高,就会判定你是采集网站的内容,抄袭别人的内容,所以得不到收录和排名。最后,新生成的文章链接一定要及时主动推送给搜索引擎,这样才能保证你的网站更多收录,也让搜索引擎知道你的更新频率!并且必须是 伪原创!因为蜘蛛在爬取过程中会识别你的文章内容。如果重复率太高,就会判定你是采集网站的内容,抄袭别人的内容,所以得不到收录和排名。最后,新生成的文章链接一定要及时主动推送给搜索引擎,这样才能保证你的网站更多收录,也让搜索引擎知道你的更新频率!

其实想要网站做好,还有很多维度需要解决。今天小编主要讲和采集分享一些经验。做网站优化,我们必须考虑到每一个维度。编辑器可以做一个网站从零到五次方,不仅采集做得好,从一开始的域名服务器选择,再到后期的站点优化和异地优化,我研究点点滴滴,各方面都做好。我会陆续和大家分享更多的SEO相关知识。网站管理员可以喜欢、关注和添加到采集夹。同时也可以在评论区分享自己的一些SEO心得,让大家一起学习成长!

网站程序自带的采集器采集文章(优采云采集程序负责根据工作流对网页数据采集(组图))

采集交流 • 优采云 发表了文章 • 0 个评论 • 178 次浏览 • 2021-11-23 09:09

优采云采集 原理

优采云网页数据采集 客户端使用的开发语言是C#,运行在Windows上。客户端主程序负责任务配置与管理、任务云采集控制、云集成数据管理(导出、清理、发布)。数据导出程序负责将数据导出为Excel、SQL、TXT、MYSQL等,支持一次导出百万条数据。本地采集程序负责根据工作流打开和抓取网页,采集数据用于通过正则表达式和Xpath原理快速获取网页数据。

整个采集流程基于Firefox内核浏览器,通过模拟人的思维操作(如打开网页、点击网页中的按钮)自动提取网页内容。系统将过程操作完全可视化,无需专业知识,轻松实现数据采集。通过准确定位网页源代码中每条数据的XPath路径,优采云可以准确的采集批量输出用户需要的数据。

优采云实现的功能

优采云网页数据采集 系统基于完全自主研发的分布式云计算平台。它可以在短时间内轻松地从各种网站或网页中获取大量数据。标准化数据,帮助任何需要从网页获取信息的客户实现数据自动化采集、编辑、标准化,摆脱对人工搜索和数据采集的依赖,从而降低获取信息的成本,提高效率。涉及政府、高校、企业、银行、电子商务、科研、汽车、房地产、媒体等多个行业和领域。

图1:采集示意图

优采云作为一般的网页数据采集器,并不是针对某个网站某个行业的数据采集,而是在网页上可以看到或者几乎所有的网页源码中的文字信息可以是采集,市面上98%的网页都可以使用优采云来表示采集。

使用本地采集(单机采集),除了抓取大部分网页数据外,还可以在采集过程中进行初步的数据清洗。如果使用程序自带的正则工具,请使用正则表达式来格式化数据。可以在数据源实现去除空格、过滤日期等各种操作。其次,优采云还提供了分支判断功能,可以对网页中的信息是否正确进行逻辑判断,从而达到用户筛选需求。

除了本地采集(单机采集)的所有功能外,云端采集还可以实现定时采集、实时监控、自动重复数据删除和存储,并增加采集的数量,验证码自动识别,API接口多样化,导出数据和修改参数。同时,使用云端并发运行多个节点,采集的速度会比本地的采集(单机采集)快很多,并且自动切换任务启动时的多个IP也可以避免网站 IP块,实现采集比较完整的数据。

图 2:时序云采集 查看全部

网站程序自带的采集器采集文章(优采云采集程序负责根据工作流对网页数据采集(组图))

优采云采集 原理

优采云网页数据采集 客户端使用的开发语言是C#,运行在Windows上。客户端主程序负责任务配置与管理、任务云采集控制、云集成数据管理(导出、清理、发布)。数据导出程序负责将数据导出为Excel、SQL、TXT、MYSQL等,支持一次导出百万条数据。本地采集程序负责根据工作流打开和抓取网页,采集数据用于通过正则表达式和Xpath原理快速获取网页数据。

整个采集流程基于Firefox内核浏览器,通过模拟人的思维操作(如打开网页、点击网页中的按钮)自动提取网页内容。系统将过程操作完全可视化,无需专业知识,轻松实现数据采集。通过准确定位网页源代码中每条数据的XPath路径,优采云可以准确的采集批量输出用户需要的数据。

优采云实现的功能

优采云网页数据采集 系统基于完全自主研发的分布式云计算平台。它可以在短时间内轻松地从各种网站或网页中获取大量数据。标准化数据,帮助任何需要从网页获取信息的客户实现数据自动化采集、编辑、标准化,摆脱对人工搜索和数据采集的依赖,从而降低获取信息的成本,提高效率。涉及政府、高校、企业、银行、电子商务、科研、汽车、房地产、媒体等多个行业和领域。

图1:采集示意图

优采云作为一般的网页数据采集器,并不是针对某个网站某个行业的数据采集,而是在网页上可以看到或者几乎所有的网页源码中的文字信息可以是采集,市面上98%的网页都可以使用优采云来表示采集。

使用本地采集(单机采集),除了抓取大部分网页数据外,还可以在采集过程中进行初步的数据清洗。如果使用程序自带的正则工具,请使用正则表达式来格式化数据。可以在数据源实现去除空格、过滤日期等各种操作。其次,优采云还提供了分支判断功能,可以对网页中的信息是否正确进行逻辑判断,从而达到用户筛选需求。

除了本地采集(单机采集)的所有功能外,云端采集还可以实现定时采集、实时监控、自动重复数据删除和存储,并增加采集的数量,验证码自动识别,API接口多样化,导出数据和修改参数。同时,使用云端并发运行多个节点,采集的速度会比本地的采集(单机采集)快很多,并且自动切换任务启动时的多个IP也可以避免网站 IP块,实现采集比较完整的数据。

图 2:时序云采集

网站程序自带的采集器采集文章( 关于网页采集器的使用方法,以及我是如何通过本篇把网站做到权五的 )

采集交流 • 优采云 发表了文章 • 0 个评论 • 153 次浏览 • 2021-11-23 09:09

关于网页采集器的使用方法,以及我是如何通过本篇把网站做到权五的

)

关于如何使用采集器网页,以及我如何使用采集器制作网站全舞。通过这篇文章,我将与大家分享采集器的一些使用技巧。看完你就会明白,把网站做到五点并不难!作为一个站长,我现在手头有将近一千个网站。我需要每天维护我的网站。最重要的是要填写网站的内容,手动肯定是做不到的。这个工作做完了,所以我总是用免费的采集器到文章采集,填上我自己的网站的内容。接下来说一下采集器怎么用好,以及一些增加网站权重的小方法。

关于如何使用采集器网页,以及我如何使用采集器制作网站全舞。通过这篇文章,我将与大家分享采集器的一些使用技巧。看完你就会明白,把网站做到五点并不难!作为一个站长,我现在手头有将近一千个网站。我需要每天维护我的网站。最重要的是要填写网站的内容,手动肯定是做不到的。这个工作做完了,所以我总是用免费的采集器到文章采集,填上我自己的网站的内容。接下来说一下采集器怎么用好,以及一些增加网站权重的小方法。

首先,我告诉你为什么我们使用采集器 而不是自己创建网站 内容。目前,大多数站长和企业网站管理员需要不止一个网站日常维护,比如上万个域名。那么这么多网站的内容是哪里来的呢?你只能用采集的内容填写你自己的网站。

那我就告诉你一个采集器的选择。市场上有采集器几千万,大家都说好。小编总结为fit最好,必须满足以下几点:第一,成本问题,现在做站难,大部分站长都很难维护,小编认为免费是最好的!第二点是操作问题。毕竟大部分站长都不知道怎么写代码和采集规则,所以操作一定要非常简单,让一个什么都不知道的站长也能正常使用。第三点是实际问题。简单设置之后,最好挂断,不管什么样的,让他不停的接,不停的提供文章给网站。第四点,采集的来源一定要丰富。采集 的多平台资源非常重要。这样可以防止文章被同质化。它也可以用于不同的搜索。适用于收录。只要能同时满足这几点,就适合我们。编辑一直通过免费采集器文章采集来做,不仅可以满足日常网站 采集数量需求,而且操作非常简单. 简单配置后,放在那里挂断采集。采集,不仅可以满足日常网站 采集的数量需求,而且操作非常简单。简单配置后,放在那里挂断采集。采集,不仅可以满足日常网站 采集的数量需求,而且操作非常简单。简单配置后,放在那里挂断采集。

那我是怎么用采集来组成网站的呢?很多站长都说采集站大部分都是垃圾站。那是因为你根本没有做。很多人说采集站很容易被搜索引擎攻击。这就是为什么你不能这样做!说说我的方法吧。采集的来源肯定更多。以百度为例,我会多一些采集一些标题文章。原因很简单。头条封杀百度。头条蜘蛛,那么头条文章很有可能百度没有收录,所以采集过去文章的优质内容会更好。第二点,采集一定要针对采集,比如你的网站是装修网,那么你的采集文章 而且标题一定要符合你的网站定位,不想穿,做装饰采集旅游资讯。第三点是采集中的文章必须被处理,而且必须是伪原创!因为蜘蛛在爬取过程中会识别出你的文章的内容,如果重复次数太高,会判断你是采集的站点,复制别人的内容,这样你就可以't get 收录 和排名。最后,新生成的文章链接一定要及时主动推送给搜索引擎,这样才能保证你的网站更多收录,也让搜索引擎知道你的一 更新频率!第三点是采集中的文章必须被处理,而且必须是伪原创!因为蜘蛛在爬取过程中会识别出你的文章的内容,如果重复次数太高,会判断你是采集的站点,复制别人的内容,这样你就可以't get 收录 和排名。最后,新生成的文章链接一定要及时主动推送给搜索引擎,这样才能保证你的网站更多收录,也让搜索引擎知道你的一 更新频率!第三点是采集中的文章必须被处理,而且必须是伪原创!因为蜘蛛在爬取过程中会识别出你的文章的内容,如果重复次数太高,会判断你是采集的站点,复制别人的内容,这样你就可以't get 收录 和排名。最后,新生成的文章链接一定要及时主动推送给搜索引擎,这样才能保证你的网站更多收录,也让搜索引擎知道你的一 更新频率!复制别人的内容,这样你就得不到收录和排名。最后,新生成的文章链接一定要及时主动推送给搜索引擎,这样才能保证你的网站更多收录,也让搜索引擎知道你的一 更新频率!复制别人的内容,这样你就得不到收录和排名。最后,新生成的文章链接一定要及时主动推送给搜索引擎,这样才能保证你的网站更多收录,也让搜索引擎知道你的一 更新频率!

其实想要网站做好,还有很多维度需要解决。今天小编主要讲和采集分享一些经验。做网站优化,我们必须考虑到每一个维度。编辑器可以做一个网站从零到五次方,不仅采集做得好,从一开始的域名服务器选择,再到后期的站点优化和异地优化,我研究把每一点都学好,各方面都做好。我会陆续和大家分享更多的SEO相关知识。网站管理员可以喜欢、关注和添加到采集夹。同时,大家可以在评论区分享自己的一些SEO心得,大家一起学习成长!

查看全部

网站程序自带的采集器采集文章(

关于网页采集器的使用方法,以及我是如何通过本篇把网站做到权五的

)

关于如何使用采集器网页,以及我如何使用采集器制作网站全舞。通过这篇文章,我将与大家分享采集器的一些使用技巧。看完你就会明白,把网站做到五点并不难!作为一个站长,我现在手头有将近一千个网站。我需要每天维护我的网站。最重要的是要填写网站的内容,手动肯定是做不到的。这个工作做完了,所以我总是用免费的采集器到文章采集,填上我自己的网站的内容。接下来说一下采集器怎么用好,以及一些增加网站权重的小方法。

关于如何使用采集器网页,以及我如何使用采集器制作网站全舞。通过这篇文章,我将与大家分享采集器的一些使用技巧。看完你就会明白,把网站做到五点并不难!作为一个站长,我现在手头有将近一千个网站。我需要每天维护我的网站。最重要的是要填写网站的内容,手动肯定是做不到的。这个工作做完了,所以我总是用免费的采集器到文章采集,填上我自己的网站的内容。接下来说一下采集器怎么用好,以及一些增加网站权重的小方法。

首先,我告诉你为什么我们使用采集器 而不是自己创建网站 内容。目前,大多数站长和企业网站管理员需要不止一个网站日常维护,比如上万个域名。那么这么多网站的内容是哪里来的呢?你只能用采集的内容填写你自己的网站。

那我就告诉你一个采集器的选择。市场上有采集器几千万,大家都说好。小编总结为fit最好,必须满足以下几点:第一,成本问题,现在做站难,大部分站长都很难维护,小编认为免费是最好的!第二点是操作问题。毕竟大部分站长都不知道怎么写代码和采集规则,所以操作一定要非常简单,让一个什么都不知道的站长也能正常使用。第三点是实际问题。简单设置之后,最好挂断,不管什么样的,让他不停的接,不停的提供文章给网站。第四点,采集的来源一定要丰富。采集 的多平台资源非常重要。这样可以防止文章被同质化。它也可以用于不同的搜索。适用于收录。只要能同时满足这几点,就适合我们。编辑一直通过免费采集器文章采集来做,不仅可以满足日常网站 采集数量需求,而且操作非常简单. 简单配置后,放在那里挂断采集。采集,不仅可以满足日常网站 采集的数量需求,而且操作非常简单。简单配置后,放在那里挂断采集。采集,不仅可以满足日常网站 采集的数量需求,而且操作非常简单。简单配置后,放在那里挂断采集。

那我是怎么用采集来组成网站的呢?很多站长都说采集站大部分都是垃圾站。那是因为你根本没有做。很多人说采集站很容易被搜索引擎攻击。这就是为什么你不能这样做!说说我的方法吧。采集的来源肯定更多。以百度为例,我会多一些采集一些标题文章。原因很简单。头条封杀百度。头条蜘蛛,那么头条文章很有可能百度没有收录,所以采集过去文章的优质内容会更好。第二点,采集一定要针对采集,比如你的网站是装修网,那么你的采集文章 而且标题一定要符合你的网站定位,不想穿,做装饰采集旅游资讯。第三点是采集中的文章必须被处理,而且必须是伪原创!因为蜘蛛在爬取过程中会识别出你的文章的内容,如果重复次数太高,会判断你是采集的站点,复制别人的内容,这样你就可以't get 收录 和排名。最后,新生成的文章链接一定要及时主动推送给搜索引擎,这样才能保证你的网站更多收录,也让搜索引擎知道你的一 更新频率!第三点是采集中的文章必须被处理,而且必须是伪原创!因为蜘蛛在爬取过程中会识别出你的文章的内容,如果重复次数太高,会判断你是采集的站点,复制别人的内容,这样你就可以't get 收录 和排名。最后,新生成的文章链接一定要及时主动推送给搜索引擎,这样才能保证你的网站更多收录,也让搜索引擎知道你的一 更新频率!第三点是采集中的文章必须被处理,而且必须是伪原创!因为蜘蛛在爬取过程中会识别出你的文章的内容,如果重复次数太高,会判断你是采集的站点,复制别人的内容,这样你就可以't get 收录 和排名。最后,新生成的文章链接一定要及时主动推送给搜索引擎,这样才能保证你的网站更多收录,也让搜索引擎知道你的一 更新频率!复制别人的内容,这样你就得不到收录和排名。最后,新生成的文章链接一定要及时主动推送给搜索引擎,这样才能保证你的网站更多收录,也让搜索引擎知道你的一 更新频率!复制别人的内容,这样你就得不到收录和排名。最后,新生成的文章链接一定要及时主动推送给搜索引擎,这样才能保证你的网站更多收录,也让搜索引擎知道你的一 更新频率!

其实想要网站做好,还有很多维度需要解决。今天小编主要讲和采集分享一些经验。做网站优化,我们必须考虑到每一个维度。编辑器可以做一个网站从零到五次方,不仅采集做得好,从一开始的域名服务器选择,再到后期的站点优化和异地优化,我研究把每一点都学好,各方面都做好。我会陆续和大家分享更多的SEO相关知识。网站管理员可以喜欢、关注和添加到采集夹。同时,大家可以在评论区分享自己的一些SEO心得,大家一起学习成长!

网站程序自带的采集器采集文章(深网是网络的一部分,与浅网(surfaceWeb)对立)

采集交流 • 优采云 发表了文章 • 0 个评论 • 168 次浏览 • 2021-11-20 07:07

在上一篇文章中,我们意识到一个网站从一个链接随机跳转到另一个链接。但是,如果需要将整个网站按类别系统地归类,或者搜索网站上的每一页,则必须采集整个网站,这非常在消耗内存资源的过程,尤其是处理大的网站时,最合适的工具是使用数据库来存储采集的资源。

1. 深网和暗网

您可能听说过诸如深网、暗网或隐藏网之类的术语,尤其是在最近的媒体中。他们的意思是什么?深网是网的一部分,与表网相反。浅层网络是网络中可以被互联网上的搜索引擎捕获的部分。据不完全统计,大约90%的互联网实际上是一个深网。因为谷歌不能做表单提交之类的事情,也不能找到没有直接链接到顶级域名的网页,或者因为robots.txt禁止而无法查看网站,所以数浅网比较深。还是比较少的。

暗网,也称为暗网或暗网,完全是另一种“怪物”。它们也是建立在现有网络的基础上,但使用 Tor 客户端,在 HTTP 之上运行一个新协议,并为信息交换提供安全隧道。这样的暗网也可以是采集,就像你的采集其他网站,不过这些内容超出了本章的范围。

与暗网不同,深网相对容易采集。它可以让你采集那些谷歌爬虫机器人无法获取的深层网络信息。

2.遍历整个网站网络数据采集有很多好处:

(1)生成网站地图

使用爬虫采集整个网站,采集所有的链接,然后将所有的页面组织成网站的实际形式。

(2)采集数据

创建专业垂直搜索平台,想采集一些文章(博客、新闻、故事等)。虽然这些网站采集并不费劲,但是需要爬虫有足够的深度(我们打算有网站的猴子应急数据不多)。所以创建一个爬虫来递归遍历每个网站,只采集那些网站页面上的数据。一种常见且耗时的网站采集方法是从首页(如首页)开始,然后搜索页面上的所有链接,形成一个列表。然后去这些链接的每一页采集,然后将每一页找到的链接组成一个新的列表,重复下一轮采集。

显然,这是一种复杂性迅速增长的情况。如果每个页面有10个链接,而网站上有5个页面深度(中等规模的主流深度),那么如果你想要采集整个网站,一共采集 的网页数量为 10^5,即 100,000 页。不过,虽然“5页深度,每页10个链接”是网站的主流配置,但实际上,真正拥有10万个以上页面的网站却寥寥无几。这是因为大部分链是重复的。

为了防止一个页面被采集两次,去除重复链接非常重要。代码运行时,将所有找到的链接放在一起,保存在一个方便查询的列表中(下面的例子指的是Python的set类型)。只有新链接会采集,然后从页面搜索其他链接。

from urllib.request import urlopen

from bs4 import BeautifulSoup

import re

pages=set()

def getLinks(pageUrl):

global pages

html=urlopen("https://en.wikipedia.org"+pageUrl)

bsObj=BeautifulSoup(html,"html.parser")

for link in bsObj.findAll("a",href=re.compile("^(/wiki/)")):

if 'href' in link.attrs:

if link.attrs["href"] not in pages:

print(newPage)

newPage=link.attrs["href"]

pages.add(newPage)

getLinks(newPage)

getLinks("")

为了充分展示这个网络数据 采集 示例的工作原理,我删除了“只查找内部链接”标准。不再限制爬虫采集的页面范围,只要遇到一个页面,就会查找所有以/wiki/开头的链接,无论链接是否收录分号。

一开始用getLinks处理一个空的URL,其实就是维基百科的首页,因为空的URL在函数中。然后遍历首页的每个链接,查看是否已经在全局变量pages集合中。如果不是,则将其打印到屏幕并添加到页面集合中,然后使用 getLinks 递归处理该链接。这里需要注意的一点是python的默认递归限制是1000次,当达到递归限制时程序会自动停止。

3. 采集整个 网站 数据

当然,如果你只是从一个页面跳转到另一个页面,那么网络爬虫是很无聊的。为了有效地使用它们,我们需要在使用爬虫时在页面上做一些事情。让我们看看如何创建一个爬虫来采集页面标题、正文的第一段和编辑页面的链接(如果有的话)。

和往常一样,决定如何做这些事情的第一步是观察网站上的一些页面,然后绘制一个采集模式。通过观察几个维基百科页面,包括条目页面和非术语页面,例如隐私政策页面,您将获得以下规则:

(1)所有的标题(在所有页面上,无论是入口页面、编辑历史页面还是其他页面)都在h1-span标签中,页面上只有一个h1标签;

(前面提到2),所有的正文文本都在div#bodyContent标签中。但是,如果我们想进一步获取第一段文本,我们可能使用div#mw-contet-text->p更好(仅选择第一段的标签。此规则适用于所有页面,除了文件页面,它不收录部分内容文本(内容文本)

(3)编辑链接只出现在入口页面,如果有编辑链接,都在li#ca-edit->span->a。

完整的程序代码如下:

from urllib.request import urlopen

from bs4 import BeautifulSoup

import re

pages=set()

def getLinks(pageUrl):

global pages

html=urlopen("https://en.wikipedia.org"+pageUrl)

bsObj=BeautifulSoup(html,"html.parser")

try:

print(bsObj.h1.get_text())

print(bsObj.find(id="mw-content-text").findAll("p")[0])

print(bsObj.find(id="ca-edit").find("span").find("a").attrs['href'])

except AttributeError:

print("页面缺少一些属性,Don't worry")

for link in bsObj.findAll("a",href=re.compile("^(/wiki/)")):

if 'href' in link.attrs:

if link.attrs["href"] not in pages:

print("---------\n"+newPage)

newPage=link.attrs["href"]

pages.add(newPage)

getLinks(newPage)

getLinks("")

因为我们不可能保证每一页上都有所有类型的数据,所以每个打印语句都是按照数据出现在页面上的概率降序排列的。换句话说,标题标签会出现在每一页上,所以我们首先尝试获取它的数据。正文内容会出现在大多数页面(文件页面除外),所以它是第二个获取的数据。“编辑”按钮只出现在获取了标题和正文内容的页面上,并不是所有页面都有,所以放在最后。 查看全部

网站程序自带的采集器采集文章(深网是网络的一部分,与浅网(surfaceWeb)对立)

在上一篇文章中,我们意识到一个网站从一个链接随机跳转到另一个链接。但是,如果需要将整个网站按类别系统地归类,或者搜索网站上的每一页,则必须采集整个网站,这非常在消耗内存资源的过程,尤其是处理大的网站时,最合适的工具是使用数据库来存储采集的资源。

1. 深网和暗网

您可能听说过诸如深网、暗网或隐藏网之类的术语,尤其是在最近的媒体中。他们的意思是什么?深网是网的一部分,与表网相反。浅层网络是网络中可以被互联网上的搜索引擎捕获的部分。据不完全统计,大约90%的互联网实际上是一个深网。因为谷歌不能做表单提交之类的事情,也不能找到没有直接链接到顶级域名的网页,或者因为robots.txt禁止而无法查看网站,所以数浅网比较深。还是比较少的。

暗网,也称为暗网或暗网,完全是另一种“怪物”。它们也是建立在现有网络的基础上,但使用 Tor 客户端,在 HTTP 之上运行一个新协议,并为信息交换提供安全隧道。这样的暗网也可以是采集,就像你的采集其他网站,不过这些内容超出了本章的范围。

与暗网不同,深网相对容易采集。它可以让你采集那些谷歌爬虫机器人无法获取的深层网络信息。

2.遍历整个网站网络数据采集有很多好处:

(1)生成网站地图

使用爬虫采集整个网站,采集所有的链接,然后将所有的页面组织成网站的实际形式。

(2)采集数据