网站内容抓取

网站内容抓取(Excel教程Excel函数Excel表格制作Excel2010Excel实用技巧Excel视频教程)

网站优化 • 优采云 发表了文章 • 0 个评论 • 72 次浏览 • 2021-10-11 22:16

我对网页内容的爬取比较感兴趣,所以就简单的学习了一下。如果我不使用任何框架来抓取网页内容,感觉有点困难。我会继续前进。这里使用的jsoup框架,爬取网页的内容和使用jquery选择网页的内容类似,上手很快。下面就来简单介绍一下吧!

首先是获取网络资源的方法:

/**

* 获取网络中的超链接

*

* @param urlStr

* 传入网络地址

* @return 返回网页中的所有的超链接信息

*/

public String getInternet(String urlStr, String encoding) {

URL url = null;

URLConnection conn = null;

String nextLine = null;

StringBuffer sb = new StringBuffer();

// 设置系统的代理信息

Properties props = System.getProperties();

props.put("proxySet", "true");

props.put("proxyHost", "10.27.16.212");

props.put("proxyPort", "3128");

System.setProperties(props);

try {

// 获取网络资源

url = new URL(urlStr);

// 获取资源连接

conn = url.openConnection();

conn.setReadTimeout(30000);//设置30秒后超时

conn.connect();

BufferedReader reader = new BufferedReader(new InputStreamReader(

conn.getInputStream(), encoding));

// 开始读取网页信息获取网页中的超链接信息

while ((nextLine = reader.readLine()) != null) {

sb.append(nextLine);

}

} catch (Exception e) {

e.printStackTrace();

}

return sb.toString();

}

获取到网络资源后,我们可以根据自己的需要筛选出对自己有用的资源,下面开始抢资源:

public static void main(String[] args) {

MavenTest test = new MavenTest();

try {

String html = test.getInternet( "http://www.weather.com.cn/html ... ot%3B,"UTF-8");

//将html文档转换为Document文档

Document doc = Jsoup.parse(html);

//获取class为.weatherYubaoBox的div的元素

Elements tableElements = doc.select("div.weatherYubaoBox");

// System.out.println(tableElements.html());

//获取所有的th元素

Elements thElements = tableElements.select("th");

//打印出日期的标题信息

for (int i = 0; i < thElements.size(); i++) {

System.out.print(" "+thElements.get(i).text() + "\t");

}

// 输出标题之后进行换行

System.out.println();

//获取表格的tbody

Elements tbodyElements = tableElements.select("tbody");

for (int j = 1; j < tbodyElements.size(); j++) {

//获取tr中的信息

Elements trElements = tbodyElements.get(j).select("tr");

for (int k = 0; k < trElements.size(); k++) {

//获取单元格中的信息

Elements tdElements = trElements.get(k).select("td");

//根据元素的多少判断出白天和夜晚的

if (tdElements.size() > 6) {

for (int m = 0; m < tdElements.size(); m++) {

System.out.print(tdElements.get(m).text() + "\t");

}

// 白天的数据打印完成后进行换行

System.out.println();

}else{

for(int n =0; n < tdElements.size(); n++){

System.out.print("\t"+tdElements.get(n).text());

}

//打印完成夜间的天气信息进行换行处理

System.out.println();

}

}

}

} catch (Exception e) {

e.printStackTrace();

}

}

操作结果如下:

最后,附上框架的地址: 查看全部

网站内容抓取(Excel教程Excel函数Excel表格制作Excel2010Excel实用技巧Excel视频教程)

我对网页内容的爬取比较感兴趣,所以就简单的学习了一下。如果我不使用任何框架来抓取网页内容,感觉有点困难。我会继续前进。这里使用的jsoup框架,爬取网页的内容和使用jquery选择网页的内容类似,上手很快。下面就来简单介绍一下吧!

首先是获取网络资源的方法:

/**

* 获取网络中的超链接

*

* @param urlStr

* 传入网络地址

* @return 返回网页中的所有的超链接信息

*/

public String getInternet(String urlStr, String encoding) {

URL url = null;

URLConnection conn = null;

String nextLine = null;

StringBuffer sb = new StringBuffer();

// 设置系统的代理信息

Properties props = System.getProperties();

props.put("proxySet", "true");

props.put("proxyHost", "10.27.16.212");

props.put("proxyPort", "3128");

System.setProperties(props);

try {

// 获取网络资源

url = new URL(urlStr);

// 获取资源连接

conn = url.openConnection();

conn.setReadTimeout(30000);//设置30秒后超时

conn.connect();

BufferedReader reader = new BufferedReader(new InputStreamReader(

conn.getInputStream(), encoding));

// 开始读取网页信息获取网页中的超链接信息

while ((nextLine = reader.readLine()) != null) {

sb.append(nextLine);

}

} catch (Exception e) {

e.printStackTrace();

}

return sb.toString();

}

获取到网络资源后,我们可以根据自己的需要筛选出对自己有用的资源,下面开始抢资源:

public static void main(String[] args) {

MavenTest test = new MavenTest();

try {

String html = test.getInternet( "http://www.weather.com.cn/html ... ot%3B,"UTF-8");

//将html文档转换为Document文档

Document doc = Jsoup.parse(html);

//获取class为.weatherYubaoBox的div的元素

Elements tableElements = doc.select("div.weatherYubaoBox");

// System.out.println(tableElements.html());

//获取所有的th元素

Elements thElements = tableElements.select("th");

//打印出日期的标题信息

for (int i = 0; i < thElements.size(); i++) {

System.out.print(" "+thElements.get(i).text() + "\t");

}

// 输出标题之后进行换行

System.out.println();

//获取表格的tbody

Elements tbodyElements = tableElements.select("tbody");

for (int j = 1; j < tbodyElements.size(); j++) {

//获取tr中的信息

Elements trElements = tbodyElements.get(j).select("tr");

for (int k = 0; k < trElements.size(); k++) {

//获取单元格中的信息

Elements tdElements = trElements.get(k).select("td");

//根据元素的多少判断出白天和夜晚的

if (tdElements.size() > 6) {

for (int m = 0; m < tdElements.size(); m++) {

System.out.print(tdElements.get(m).text() + "\t");

}

// 白天的数据打印完成后进行换行

System.out.println();

}else{

for(int n =0; n < tdElements.size(); n++){

System.out.print("\t"+tdElements.get(n).text());

}

//打印完成夜间的天气信息进行换行处理

System.out.println();

}

}

}

} catch (Exception e) {

e.printStackTrace();

}

}

操作结果如下:

最后,附上框架的地址:

网站内容抓取(横琴建站:中小企业在做网站建设时需要注意哪些问题?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 59 次浏览 • 2021-10-11 01:40

导读:随着企业的快速发展壮大,越来越多的中小企业重视品牌网站建设和营销网站建设,想利用互联网提升品牌知名度并获得更多潜在的合作机会和更精准的客户。但是,企业网站的建设与普通的网站不同。这就需要深入的行业研究,挖掘出公司各方面的优势,塑造独特的企业形象,尤其是很多细节,直接影响到公司。网站@的作用和目的>,应该注意哪些问题中小企业在做网站建设时注意什么?下面横琴建个网站跟大家分享一下SEO的相关知识。

部分内容质量较高的网页用户可以正常访问,但百度Pider无法正常访问和抓取,导致搜索结果覆盖不足,给百度搜索引擎和网站造成损失。百度称这种情况为“抢占异常”。百度搜索引擎会认为内容量大的网站存在无法正常抓取的用户体验缺陷,降低对网站的评价。在抓取、索引和排序方面,百度搜索引擎将受到影响。这会影响网站从百度获得的流量。

下面介绍一些常见的站长爬虫异常的原因:

服务器连接异常有两种情况:一种是网站不稳定,百度PIDer尝试连接时暂时无法连接到你的网站服务器;另一种是百度PIDer一直无法连接到你的网站服务器。

服务器连接异常的原因通常是你的网站服务器太大,过载。您的 网站 也可能运行异常。请检查网站的web服务器(如apache、iis)是否安装运行正常,并使用浏览器查看主页是否可以正常访问。您的 网站 和主机也可能会阻止百度蜘蛛的访问。您需要检查网站的防火墙和主机。

网络运营商的例外:网络运营商分为电信和联通两种。百度Pider无法通过电信或网通访问您的网站。如果出现这种情况,您需要联系网络服务商,或者购买空间和二线服务或CDN服务。

DNS异常:当百度蜘蛛无法解析您的网站 IP地址时,会发生DNS异常。可能是你的网站 IP地址错误,或者域名服务商已经屏蔽了百度蜘蛛。请使用 whois 或 host 来检查您的 网站 IP 地址是否正确且可解析。如果没有,请联系域名注册商更新您的 IP 地址。

IP阻塞:IP阻塞是限制网络的导出IP地址,禁止该IP段的用户访问内容。这里特指对百度Piderip的屏蔽。仅当您的 网站 不希望百度 Pider 访问时才需要此设置。如果您希望百度Pider访问您的网站,请检查相关设置中是否错误添加了百度Pider IP。你的网站所在的空间服务商也可能封禁百度IP。这时候需要联系服务商更改设置。

UA 阻塞:UA 是用户代理服务器通过 UA 识别的访问者的身份。当一个网站访问指定的UA返回异常页面(如403500)或跳转到另一个页面时,称为UA阻塞。这个设置只在你不想要baidupider的时候使用访问你的网站只需要,如果你想让百度皮德访问你的网站,在用户代理相关设置中是否有百度皮德如,并及时修改。

死链接:页面无效,不能为用户提供任何有价值信息的页面为死链接,包括协议死链接和内容死链接

协议死链接:页面的TCP协议状态/HTTP协议状态明确显示死链接,如404、403、503状态等。

内容死链接:服务器返回的状态正常,但内容已更改为不存在、已删除或需要权限的页面,与原内容无关。

对于死链接,我们建议网站使用协议死链接,通过百度站长平台的死链接工具提交给百度,这样百度可以更快的找到死链接,减少死链接对用户和搜索的负面影响引擎。

异常跳转:跳转就是将网络请求重定向到另一个位置。异常跳转是指以下几种情况:

1)当前页面为无效页面(内容已删除、死链接等),直接跳转到上一目录或首页,百度建议站长删除无效页面的入口超链接

对于长期重定向到其他域名,例如在网站上更改域名,百度建议使用301重定向协议进行设置。

其他例外:

1) 百度推荐人异常:网页返回与百度推荐人正常内容不同的行为。

2) 百度UA异常:返回百度UA的网页行为与页面原创内容不同。

3)JS跳转异常:网页加载了百度无法识别的JS跳转代码,用户通过搜索结果进入网页后跳转。

4) 压力过大导致意外阻塞:百度会根据网站规模、流量等信息自动设置合理的爬取压力。但是,在异常压力控制等异常情况下,服务器会根据自身负载受到保护和意外锁定。在这种情况下,请在返回码中返回503(表示“服务不可用”),以便百度Pider在一段时间内再次尝试获取链接。如果网站处于空闲状态,将成功获取网站。

横琴工地网络营销托管代理运营服务商,专注中小企业网络营销技术服务,为中小企业提供企业网站建设、网络营销托管代理运营、SEM托管代理运营、SEO站群建设、企业网站代理运营、小程序开发推广、广告媒体发布代理运营、美团小红书代理运营、微信公众号代理运营等及中小企业宣传、营销推广、技术开发、精准客户在相关服务方面,我们致力于成为合作企业的网络营销外包托管代理服务商。 查看全部

网站内容抓取(横琴建站:中小企业在做网站建设时需要注意哪些问题?)

导读:随着企业的快速发展壮大,越来越多的中小企业重视品牌网站建设和营销网站建设,想利用互联网提升品牌知名度并获得更多潜在的合作机会和更精准的客户。但是,企业网站的建设与普通的网站不同。这就需要深入的行业研究,挖掘出公司各方面的优势,塑造独特的企业形象,尤其是很多细节,直接影响到公司。网站@的作用和目的>,应该注意哪些问题中小企业在做网站建设时注意什么?下面横琴建个网站跟大家分享一下SEO的相关知识。

部分内容质量较高的网页用户可以正常访问,但百度Pider无法正常访问和抓取,导致搜索结果覆盖不足,给百度搜索引擎和网站造成损失。百度称这种情况为“抢占异常”。百度搜索引擎会认为内容量大的网站存在无法正常抓取的用户体验缺陷,降低对网站的评价。在抓取、索引和排序方面,百度搜索引擎将受到影响。这会影响网站从百度获得的流量。

下面介绍一些常见的站长爬虫异常的原因:

服务器连接异常有两种情况:一种是网站不稳定,百度PIDer尝试连接时暂时无法连接到你的网站服务器;另一种是百度PIDer一直无法连接到你的网站服务器。

服务器连接异常的原因通常是你的网站服务器太大,过载。您的 网站 也可能运行异常。请检查网站的web服务器(如apache、iis)是否安装运行正常,并使用浏览器查看主页是否可以正常访问。您的 网站 和主机也可能会阻止百度蜘蛛的访问。您需要检查网站的防火墙和主机。

网络运营商的例外:网络运营商分为电信和联通两种。百度Pider无法通过电信或网通访问您的网站。如果出现这种情况,您需要联系网络服务商,或者购买空间和二线服务或CDN服务。

DNS异常:当百度蜘蛛无法解析您的网站 IP地址时,会发生DNS异常。可能是你的网站 IP地址错误,或者域名服务商已经屏蔽了百度蜘蛛。请使用 whois 或 host 来检查您的 网站 IP 地址是否正确且可解析。如果没有,请联系域名注册商更新您的 IP 地址。

IP阻塞:IP阻塞是限制网络的导出IP地址,禁止该IP段的用户访问内容。这里特指对百度Piderip的屏蔽。仅当您的 网站 不希望百度 Pider 访问时才需要此设置。如果您希望百度Pider访问您的网站,请检查相关设置中是否错误添加了百度Pider IP。你的网站所在的空间服务商也可能封禁百度IP。这时候需要联系服务商更改设置。

UA 阻塞:UA 是用户代理服务器通过 UA 识别的访问者的身份。当一个网站访问指定的UA返回异常页面(如403500)或跳转到另一个页面时,称为UA阻塞。这个设置只在你不想要baidupider的时候使用访问你的网站只需要,如果你想让百度皮德访问你的网站,在用户代理相关设置中是否有百度皮德如,并及时修改。

死链接:页面无效,不能为用户提供任何有价值信息的页面为死链接,包括协议死链接和内容死链接

协议死链接:页面的TCP协议状态/HTTP协议状态明确显示死链接,如404、403、503状态等。

内容死链接:服务器返回的状态正常,但内容已更改为不存在、已删除或需要权限的页面,与原内容无关。

对于死链接,我们建议网站使用协议死链接,通过百度站长平台的死链接工具提交给百度,这样百度可以更快的找到死链接,减少死链接对用户和搜索的负面影响引擎。

异常跳转:跳转就是将网络请求重定向到另一个位置。异常跳转是指以下几种情况:

1)当前页面为无效页面(内容已删除、死链接等),直接跳转到上一目录或首页,百度建议站长删除无效页面的入口超链接

对于长期重定向到其他域名,例如在网站上更改域名,百度建议使用301重定向协议进行设置。

其他例外:

1) 百度推荐人异常:网页返回与百度推荐人正常内容不同的行为。

2) 百度UA异常:返回百度UA的网页行为与页面原创内容不同。

3)JS跳转异常:网页加载了百度无法识别的JS跳转代码,用户通过搜索结果进入网页后跳转。

4) 压力过大导致意外阻塞:百度会根据网站规模、流量等信息自动设置合理的爬取压力。但是,在异常压力控制等异常情况下,服务器会根据自身负载受到保护和意外锁定。在这种情况下,请在返回码中返回503(表示“服务不可用”),以便百度Pider在一段时间内再次尝试获取链接。如果网站处于空闲状态,将成功获取网站。

横琴工地网络营销托管代理运营服务商,专注中小企业网络营销技术服务,为中小企业提供企业网站建设、网络营销托管代理运营、SEM托管代理运营、SEO站群建设、企业网站代理运营、小程序开发推广、广告媒体发布代理运营、美团小红书代理运营、微信公众号代理运营等及中小企业宣传、营销推广、技术开发、精准客户在相关服务方面,我们致力于成为合作企业的网络营销外包托管代理服务商。

网站内容抓取(做SEO优化的目地就是通过外链与内链两种操作方式)

网站优化 • 优采云 发表了文章 • 0 个评论 • 66 次浏览 • 2021-10-10 22:24

我们知道SEO优化的目的是选择关键词,通过外链、内链等方式,让搜索引擎准确快速的捕捉到目标网站的信息。在搜索信息的排名中处于极佳的位置,从而提升网站的推广效果。从专业的角度来看,要达到这个目标,必须做到以下三点:

1、原创文章内容

无论是网站首页的文章还是内页的文章,SEO优化的第一步都可以通过把握< @原创。所谓原创是网站自己写的,其内容可以是已经发生或正在发生的事件、人物、新知识、新体验等,但是在写的时候一定要原创,即网站就是这个文章的来源。现在搜索引擎更加重视原创文章。

2、做好内外部链接

网站首页权重比较高,越往内页,搜索引擎给的权重越低。我该怎么办? SEO优化导致两种操作模式:外链和内链。外链是增加友情链接网站,通过友情引流网站,带动这个网站的流量。内链是通过设置在内页文章的关键词和主关键词之间建立内连接,这样搜索引擎就会受到链接数的影响到内部页面关键词。先取。

3、注意单页链接

网站 当有特价促销,或者新品出现时,可以结合活动的促销做一些单页链接的SEO优化。通过这个推广效果明显的单页内链带动网站的流量,通过单页的推广带动整个网站有效的客户增长和销售增长也是不可忽视的活动。 查看全部

网站内容抓取(做SEO优化的目地就是通过外链与内链两种操作方式)

我们知道SEO优化的目的是选择关键词,通过外链、内链等方式,让搜索引擎准确快速的捕捉到目标网站的信息。在搜索信息的排名中处于极佳的位置,从而提升网站的推广效果。从专业的角度来看,要达到这个目标,必须做到以下三点:

1、原创文章内容

无论是网站首页的文章还是内页的文章,SEO优化的第一步都可以通过把握< @原创。所谓原创是网站自己写的,其内容可以是已经发生或正在发生的事件、人物、新知识、新体验等,但是在写的时候一定要原创,即网站就是这个文章的来源。现在搜索引擎更加重视原创文章。

2、做好内外部链接

网站首页权重比较高,越往内页,搜索引擎给的权重越低。我该怎么办? SEO优化导致两种操作模式:外链和内链。外链是增加友情链接网站,通过友情引流网站,带动这个网站的流量。内链是通过设置在内页文章的关键词和主关键词之间建立内连接,这样搜索引擎就会受到链接数的影响到内部页面关键词。先取。

3、注意单页链接

网站 当有特价促销,或者新品出现时,可以结合活动的促销做一些单页链接的SEO优化。通过这个推广效果明显的单页内链带动网站的流量,通过单页的推广带动整个网站有效的客户增长和销售增长也是不可忽视的活动。

网站内容抓取(超级排名系统原文链接:吸引百度蜘蛛抓取网站的基本条件)

网站优化 • 优采云 发表了文章 • 0 个评论 • 97 次浏览 • 2021-10-10 12:20

原文出处:超级排位系统

原文链接:吸引百度蜘蛛爬取的基本条件网站-超级排名系统

为了创建一个新的网站,我们首先考虑如何将蜘蛛吸引到我们的网站,采集我们的文章并建立一个排名。如果网站的管理员不知道怎么吸引蜘蛛,你连上手的资格都没有,那网站怎么会很快被蜘蛛抓到呢?超级排名系统的编辑会组织发布。

在互联网时代,我们想要的大部分信息都是通过“互联网搜索”获得的。比如很多人在购买某种产品之前都会上网查看相关信息,看看品牌的口碑和评价。调查显示,87%的网民会通过搜索引擎服务找到自己需要的信息,近70%的网民会直接在搜索结果自然排名的首页找到自己需要的信息。

由此可见SEO优化是非常有必要的,不仅可以提高曝光率,还可以增加销量。下面百度搜索引擎优化告诉你如何让网站快速抓取。

关键词的具体作用是在搜索引擎中排名,让用户尽快找到我的网站。所以关键词是搜索引擎优化的核心。

外链是SEO优化过程中的一个环节,间接影响着网站的权重。常见的链接有:锚文本链接、纯文本链接和图片链接。

网络爬虫是一种自动提取网页的程序,是搜索引擎的重要组成部分。例如,百度的蜘蛛爬网时需要定义网页并过滤和分析网页数据。

对于页面,爬取是收录的前提。只有爬得更多,我们才能收录更多。如果网站页面更新频繁,爬虫程序会频繁访问该页面。优质内容,尤其是原创内容,是爬虫喜欢捕捉的目标。

权威高配老网站享受VIP级待遇。这种网站的爬取频率高,爬取的页面数量大,爬取深度高,页面数量也比较多。这就是区别。

网站服务器是访问网站的基石。如果长时间打不开,就会长时间敲门。如果长时间没有回音,游客就会因为进不去,一个接着一个离开。蜘蛛来访也是访客之一。如果服务器不稳定,蜘蛛每次进入页面爬行都会被屏蔽,蜘蛛对网站的印象会越来越差,导致分数越来越低,自然排名也越来越低。

网站内容更新频繁,会吸引蜘蛛更频繁的访问。如果文章定期更新,蜘蛛会定期访问。蜘蛛每次爬取时,将页面数据存入数据库,分析后采集页面。如果蜘蛛每次爬行,发现收录的内容完全一样,蜘蛛就会判断网站,从而减少对网站的爬行。

蜘蛛的根本目的是发现有价值的“新”事物,所以原创优质内容对蜘蛛的吸引力是巨大的。如果能得到一只蜘蛛一样的,自然应该给网站打上“优秀”的标签,经常爬取网站。

抓蜘蛛是有规则的。如果它太深而无法隐藏,蜘蛛会找到自己的路。爬取过程很简单,所以网站结构应该不会太复杂。

在网站的构建中,程序可以生成大量的页面,通常是通过参数来实现的。一定要保证一个页面对应一个URL,否则会造成大量的重复内容,影响蜘蛛的抓取。如果一个页面对应的URL很多,可以尝试通过301重定向、canonical标签或者robots来处理,保证爬虫只抓取一个标准的URL。

对于新站来说,在网站建设初期,相对流量小,蜘蛛少。外链可以增加网页的曝光率和蜘蛛爬行,但需要注意外链的质量。 查看全部

网站内容抓取(超级排名系统原文链接:吸引百度蜘蛛抓取网站的基本条件)

原文出处:超级排位系统

原文链接:吸引百度蜘蛛爬取的基本条件网站-超级排名系统

为了创建一个新的网站,我们首先考虑如何将蜘蛛吸引到我们的网站,采集我们的文章并建立一个排名。如果网站的管理员不知道怎么吸引蜘蛛,你连上手的资格都没有,那网站怎么会很快被蜘蛛抓到呢?超级排名系统的编辑会组织发布。

在互联网时代,我们想要的大部分信息都是通过“互联网搜索”获得的。比如很多人在购买某种产品之前都会上网查看相关信息,看看品牌的口碑和评价。调查显示,87%的网民会通过搜索引擎服务找到自己需要的信息,近70%的网民会直接在搜索结果自然排名的首页找到自己需要的信息。

由此可见SEO优化是非常有必要的,不仅可以提高曝光率,还可以增加销量。下面百度搜索引擎优化告诉你如何让网站快速抓取。

关键词的具体作用是在搜索引擎中排名,让用户尽快找到我的网站。所以关键词是搜索引擎优化的核心。

外链是SEO优化过程中的一个环节,间接影响着网站的权重。常见的链接有:锚文本链接、纯文本链接和图片链接。

网络爬虫是一种自动提取网页的程序,是搜索引擎的重要组成部分。例如,百度的蜘蛛爬网时需要定义网页并过滤和分析网页数据。

对于页面,爬取是收录的前提。只有爬得更多,我们才能收录更多。如果网站页面更新频繁,爬虫程序会频繁访问该页面。优质内容,尤其是原创内容,是爬虫喜欢捕捉的目标。

权威高配老网站享受VIP级待遇。这种网站的爬取频率高,爬取的页面数量大,爬取深度高,页面数量也比较多。这就是区别。

网站服务器是访问网站的基石。如果长时间打不开,就会长时间敲门。如果长时间没有回音,游客就会因为进不去,一个接着一个离开。蜘蛛来访也是访客之一。如果服务器不稳定,蜘蛛每次进入页面爬行都会被屏蔽,蜘蛛对网站的印象会越来越差,导致分数越来越低,自然排名也越来越低。

网站内容更新频繁,会吸引蜘蛛更频繁的访问。如果文章定期更新,蜘蛛会定期访问。蜘蛛每次爬取时,将页面数据存入数据库,分析后采集页面。如果蜘蛛每次爬行,发现收录的内容完全一样,蜘蛛就会判断网站,从而减少对网站的爬行。

蜘蛛的根本目的是发现有价值的“新”事物,所以原创优质内容对蜘蛛的吸引力是巨大的。如果能得到一只蜘蛛一样的,自然应该给网站打上“优秀”的标签,经常爬取网站。

抓蜘蛛是有规则的。如果它太深而无法隐藏,蜘蛛会找到自己的路。爬取过程很简单,所以网站结构应该不会太复杂。

在网站的构建中,程序可以生成大量的页面,通常是通过参数来实现的。一定要保证一个页面对应一个URL,否则会造成大量的重复内容,影响蜘蛛的抓取。如果一个页面对应的URL很多,可以尝试通过301重定向、canonical标签或者robots来处理,保证爬虫只抓取一个标准的URL。

对于新站来说,在网站建设初期,相对流量小,蜘蛛少。外链可以增加网页的曝光率和蜘蛛爬行,但需要注意外链的质量。

网站内容抓取(如何分析b站同一个视频下面的弹幕和评论(图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 183 次浏览 • 2021-10-10 07:36

因为学期的项目,需要分析b站同一个视频下的弹幕和评论,所以专门研究了一下,抓到了大概100多条视频评论和弹幕。

b站的视频有两个相关的id号,一个是cid,一个是大家都知道的AV号。你需要抓住弹幕的是cid。最简单的方法就是直接查看网页源码,搜索cid,这样就可以得到单个视频的cid。然后就可以通过这个网址“/”+cid+“.xml”获取相关视频的弹幕。但问题是因为b站设置了弹幕,每个视频都有弹幕上限。如果数量达到一定数量,它将被清除。所以这个方法只能得到哈密瓜视频下方的当前弹幕。当然,如果你是批处理,需要用regular搜索cid,然后通过这个url处理xml结构文件。

对于评论,需要的是每个视频的 av 号。通过下面的网址,可以得到视频下的评论“/feedback?aid="+av号。此 URL 将返回第一页评论和三个 utf-8 格式的热门评论。还可以通过设置URL(&page=和&pagesize=)来设置最大评论数和第一页评论数。最大pagesize好像是300.

大概就是这样。完整的和具体的自动爬取代码我稍微编辑一下后会上传到github 查看全部

网站内容抓取(如何分析b站同一个视频下面的弹幕和评论(图))

因为学期的项目,需要分析b站同一个视频下的弹幕和评论,所以专门研究了一下,抓到了大概100多条视频评论和弹幕。

b站的视频有两个相关的id号,一个是cid,一个是大家都知道的AV号。你需要抓住弹幕的是cid。最简单的方法就是直接查看网页源码,搜索cid,这样就可以得到单个视频的cid。然后就可以通过这个网址“/”+cid+“.xml”获取相关视频的弹幕。但问题是因为b站设置了弹幕,每个视频都有弹幕上限。如果数量达到一定数量,它将被清除。所以这个方法只能得到哈密瓜视频下方的当前弹幕。当然,如果你是批处理,需要用regular搜索cid,然后通过这个url处理xml结构文件。

对于评论,需要的是每个视频的 av 号。通过下面的网址,可以得到视频下的评论“/feedback?aid="+av号。此 URL 将返回第一页评论和三个 utf-8 格式的热门评论。还可以通过设置URL(&page=和&pagesize=)来设置最大评论数和第一页评论数。最大pagesize好像是300.

大概就是这样。完整的和具体的自动爬取代码我稍微编辑一下后会上传到github

网站内容抓取(浅谈搜索引擎收录的抓取划定规矩有哪些?(图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 92 次浏览 • 2021-10-10 07:30

说说搜索引擎收录的爬取规则?说到SEO优化,就不得不说网站的收录问题。没有收录就不可能做SEO优化,所以不要收录 not SEO 这句话有一个积极的原则。今天,稍纵即逝的SEO于凡就和大家聊一聊搜索引擎收录的爬取规则。详细情况如下:

说说搜索引擎收录的爬取规则?

我们都知道,互联网上每天都有无数的新网页,大网站比小网站产生更多的新页面。搜索引擎倾向于从大型 网站 中搜索更多页面,因为大型 网站 通常收录更多高质量页面。搜索引擎更喜欢先抓取和采集大型网页。正是这种方式提醒站长做SEO,让更多的内容出现在网站上,强大的网页会引导搜索引擎频繁抓取和采集。这是SEO的长期计划。

搜索引擎抓取链中多个优质网页并进行优先排序

搜索引擎通过网页之间的链接关联在互联网上查找和抓取网页。大家都知道一个链接有投票功能。你得到的票数越多,搜索引擎就会关注它并抓住机会。谷歌提出的Page Rank算法可以根据链接关联对网页进行排名,并确定URL下载的顺序。因此,在SEO实践中,如果网页是收录,我们可以适当添加一条优质链。这里要特别注意“高品质”三个字。

从搜索引擎爬取的角度分析网站的采集规则

最近,发明了SEO外包优化。优化网站时,首页内容更新后,网站的排名偶尔会下降。当快照以某种方式返回时,排名恢复。仔细分析了百度站长平台的关键词和流量,发现在网站首页内容稳定的情况下,一定数量的关键词就有一定的点击量. 内容更新后,点击量下降。当快照返回时,排名再次上升。因此,推断百度在抓取和采集内容时会考虑用户体验,点击次数积极反映用户体验。

换句话说,搜索引擎将捕获并存储许多网页快照。如果旧网页快照更受用户欢迎,则不会收录新网页快照,因为搜索引擎总是考虑用户体验。

搜索引擎的资本不是无限的,他们也在竭尽全力的节省资本。。对于同样的网站,蜘蛛会根据网站的大小和更新频率来决定爬取的次数,并尽量用更少的资本来完成网站的更新策略。搜索引擎假设经常更新的页面在未来会经常更新。 查看全部

网站内容抓取(浅谈搜索引擎收录的抓取划定规矩有哪些?(图))

说说搜索引擎收录的爬取规则?说到SEO优化,就不得不说网站的收录问题。没有收录就不可能做SEO优化,所以不要收录 not SEO 这句话有一个积极的原则。今天,稍纵即逝的SEO于凡就和大家聊一聊搜索引擎收录的爬取规则。详细情况如下:

说说搜索引擎收录的爬取规则?

我们都知道,互联网上每天都有无数的新网页,大网站比小网站产生更多的新页面。搜索引擎倾向于从大型 网站 中搜索更多页面,因为大型 网站 通常收录更多高质量页面。搜索引擎更喜欢先抓取和采集大型网页。正是这种方式提醒站长做SEO,让更多的内容出现在网站上,强大的网页会引导搜索引擎频繁抓取和采集。这是SEO的长期计划。

搜索引擎抓取链中多个优质网页并进行优先排序

搜索引擎通过网页之间的链接关联在互联网上查找和抓取网页。大家都知道一个链接有投票功能。你得到的票数越多,搜索引擎就会关注它并抓住机会。谷歌提出的Page Rank算法可以根据链接关联对网页进行排名,并确定URL下载的顺序。因此,在SEO实践中,如果网页是收录,我们可以适当添加一条优质链。这里要特别注意“高品质”三个字。

从搜索引擎爬取的角度分析网站的采集规则

最近,发明了SEO外包优化。优化网站时,首页内容更新后,网站的排名偶尔会下降。当快照以某种方式返回时,排名恢复。仔细分析了百度站长平台的关键词和流量,发现在网站首页内容稳定的情况下,一定数量的关键词就有一定的点击量. 内容更新后,点击量下降。当快照返回时,排名再次上升。因此,推断百度在抓取和采集内容时会考虑用户体验,点击次数积极反映用户体验。

换句话说,搜索引擎将捕获并存储许多网页快照。如果旧网页快照更受用户欢迎,则不会收录新网页快照,因为搜索引擎总是考虑用户体验。

搜索引擎的资本不是无限的,他们也在竭尽全力的节省资本。。对于同样的网站,蜘蛛会根据网站的大小和更新频率来决定爬取的次数,并尽量用更少的资本来完成网站的更新策略。搜索引擎假设经常更新的页面在未来会经常更新。

网站内容抓取(不给nofollow加权重,你能看出什么吗?-八维教育)

网站优化 • 优采云 发表了文章 • 0 个评论 • 72 次浏览 • 2021-10-10 01:03

很多站长朋友只是认为在网站的内容中加入nofollow标签可以节省时间,让搜索引擎抓取其他内容,所以一些新站长为了改善所谓的网站 采集。我不评估这种方法的对与错。我刚刚引用了百度站长指南中的一句话,“不要给nofollow权重”。你能看到什么吗?也就是说,百度只是不计算nofollow下的链接权重,但是还是会被收录收录,省时间是无稽之谈。如果你的网站采集在一段时间内增长很大,那一定是外链建设或内容补充等其他工作做得很好,与nofollow标签无关。实际上,搜索引擎之所以不喜欢nofollow下的内容,是因为大部分内容毫无价值。蜘蛛会随着时间的推移增加访问这部分内容的周期,所以也给了我们一种不被收录里面的错觉。

删除标有 nofollow 的重复链接是否有效?

既然nofollow标签可以告诉搜索引擎什么该爬,什么不该爬,那为什么不用nofollow标签来屏蔽一些重复的链接,从而节省一定的爬行时间呢?当然这个方法没有什么害处,也会对网站造成很大的影响,但是一般来说这个方法的效果并不明显,因为根据我自己的操作经验,加入nofollow标签和它并不能像我们想象的那样节省时间,因为百度站长指着指南并明确表示蜘蛛会抓取链接。对于网站,不会重复出现,会给权重,只记录角色。蜘蛛删除重复的链接。这是一个基本的功能,因为现在更多的站长都是草根站长,对SEO不太了解。如果站长想要删除重复链接,则需要添加nofollow标签。因此,为了节省时间,没有必要使用nofollow标签去除重复链接。

nofollow标签与搜索引擎爬取的关系网站

我们可以使用nofollow标签来控制内部权重吗?

当我们知道nofollow标签可以屏蔽不必要的链接,然后整合网站的权重,一些网站管理员会倾向于使用nofollow标签来控制他们的网站的权重。一般的做法是网站管理员使用nofollow标签来屏蔽很多内页的内链,但这真的能集中网站内页的权重吗?显然,事情并没有那么简单。首先我想给大家解释一下,nofollow标签主要是外部的,而不是内部的。它的作用是删除一些没有任何价值的垃圾邮件或外部链接。如果用它来控制内页的权重,那就有点不靠谱了。因为当你想通过屏蔽内页的一些链接来整合首页的权重时,有没有想到另外一个我们需要注意的地方,那就是我们的友情链接区。交换友链的作用是互相传递权重。当我们专注于想象的重量时,它会不会散落在朋友的链上?显然,我们谁也不能保证谁都不愿意与他人分享来之不易的联系。而且,内部链接的屏蔽或多或少会影响内部页面的采集。总之,使用nofollow标签控制内页权重只能是站长自己的一厢情愿,实际操作价值不大。会不会散落在朋友圈里?显然,我们谁也不能保证谁都不愿意与他人分享来之不易的联系。而且,内部链接的屏蔽或多或少会影响内部页面的采集。总之,使用nofollow标签控制内页权重只能是站长自己的一厢情愿,实际操作价值不大。会不会散落在朋友圈里?显然,我们谁也不能保证谁都不愿意与他人分享来之不易的联系。而且,内部链接的屏蔽或多或少会影响内部页面的采集。总之,使用nofollow标签控制内页权重只能是站长自己的一厢情愿,实际操作价值不大。

在外链中嵌入nofollow标签是否会影响其物理特性?

一般来说,谷歌不会跟踪对这些网站的访问,这意味着谷歌不会通过这些链接发送PageRank或定位文字。实际上,使用nofollow 会阻止我们获取目标链接指向的网页。但是,如果其他站点在未使用 nofollow 的情况下链接到这些目标页面,或者如果它们的 URL 收录在提交给 Google 的站点地图中,这些页面可能仍会出现在索引中。请注意,其他搜索引擎可能会以与我们不同的方式处理 nofollow。

Nofollow 标签是网站管理员优化网站的一种方式。这会是一种欺骗手段吗?

当大家都知道nofollow标签可以屏蔽链接并设置网站的权重时。一些没有道德价值的站长在友情链接上做一些花招,在链接标签上加上rel="nofollow",在不降低权重的情况下欺骗别人的链接,这是司空见惯的。好在站长工具可以检测到这种做法,办法就是取消链接,“互相攻击”是没有必要的。

对比使用nofollow标签优化网站的构建,我们首先对nofollow标签有一个理性的认识。如果我们有正确的理解,我们的优化过程会更加顺畅。 查看全部

网站内容抓取(不给nofollow加权重,你能看出什么吗?-八维教育)

很多站长朋友只是认为在网站的内容中加入nofollow标签可以节省时间,让搜索引擎抓取其他内容,所以一些新站长为了改善所谓的网站 采集。我不评估这种方法的对与错。我刚刚引用了百度站长指南中的一句话,“不要给nofollow权重”。你能看到什么吗?也就是说,百度只是不计算nofollow下的链接权重,但是还是会被收录收录,省时间是无稽之谈。如果你的网站采集在一段时间内增长很大,那一定是外链建设或内容补充等其他工作做得很好,与nofollow标签无关。实际上,搜索引擎之所以不喜欢nofollow下的内容,是因为大部分内容毫无价值。蜘蛛会随着时间的推移增加访问这部分内容的周期,所以也给了我们一种不被收录里面的错觉。

删除标有 nofollow 的重复链接是否有效?

既然nofollow标签可以告诉搜索引擎什么该爬,什么不该爬,那为什么不用nofollow标签来屏蔽一些重复的链接,从而节省一定的爬行时间呢?当然这个方法没有什么害处,也会对网站造成很大的影响,但是一般来说这个方法的效果并不明显,因为根据我自己的操作经验,加入nofollow标签和它并不能像我们想象的那样节省时间,因为百度站长指着指南并明确表示蜘蛛会抓取链接。对于网站,不会重复出现,会给权重,只记录角色。蜘蛛删除重复的链接。这是一个基本的功能,因为现在更多的站长都是草根站长,对SEO不太了解。如果站长想要删除重复链接,则需要添加nofollow标签。因此,为了节省时间,没有必要使用nofollow标签去除重复链接。

nofollow标签与搜索引擎爬取的关系网站

我们可以使用nofollow标签来控制内部权重吗?

当我们知道nofollow标签可以屏蔽不必要的链接,然后整合网站的权重,一些网站管理员会倾向于使用nofollow标签来控制他们的网站的权重。一般的做法是网站管理员使用nofollow标签来屏蔽很多内页的内链,但这真的能集中网站内页的权重吗?显然,事情并没有那么简单。首先我想给大家解释一下,nofollow标签主要是外部的,而不是内部的。它的作用是删除一些没有任何价值的垃圾邮件或外部链接。如果用它来控制内页的权重,那就有点不靠谱了。因为当你想通过屏蔽内页的一些链接来整合首页的权重时,有没有想到另外一个我们需要注意的地方,那就是我们的友情链接区。交换友链的作用是互相传递权重。当我们专注于想象的重量时,它会不会散落在朋友的链上?显然,我们谁也不能保证谁都不愿意与他人分享来之不易的联系。而且,内部链接的屏蔽或多或少会影响内部页面的采集。总之,使用nofollow标签控制内页权重只能是站长自己的一厢情愿,实际操作价值不大。会不会散落在朋友圈里?显然,我们谁也不能保证谁都不愿意与他人分享来之不易的联系。而且,内部链接的屏蔽或多或少会影响内部页面的采集。总之,使用nofollow标签控制内页权重只能是站长自己的一厢情愿,实际操作价值不大。会不会散落在朋友圈里?显然,我们谁也不能保证谁都不愿意与他人分享来之不易的联系。而且,内部链接的屏蔽或多或少会影响内部页面的采集。总之,使用nofollow标签控制内页权重只能是站长自己的一厢情愿,实际操作价值不大。

在外链中嵌入nofollow标签是否会影响其物理特性?

一般来说,谷歌不会跟踪对这些网站的访问,这意味着谷歌不会通过这些链接发送PageRank或定位文字。实际上,使用nofollow 会阻止我们获取目标链接指向的网页。但是,如果其他站点在未使用 nofollow 的情况下链接到这些目标页面,或者如果它们的 URL 收录在提交给 Google 的站点地图中,这些页面可能仍会出现在索引中。请注意,其他搜索引擎可能会以与我们不同的方式处理 nofollow。

Nofollow 标签是网站管理员优化网站的一种方式。这会是一种欺骗手段吗?

当大家都知道nofollow标签可以屏蔽链接并设置网站的权重时。一些没有道德价值的站长在友情链接上做一些花招,在链接标签上加上rel="nofollow",在不降低权重的情况下欺骗别人的链接,这是司空见惯的。好在站长工具可以检测到这种做法,办法就是取消链接,“互相攻击”是没有必要的。

对比使用nofollow标签优化网站的构建,我们首先对nofollow标签有一个理性的认识。如果我们有正确的理解,我们的优化过程会更加顺畅。

网站内容抓取(网站打开速度慢对seo有影响吗?有哪些影响?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 73 次浏览 • 2021-10-10 00:51

网站打开速度慢对seo有影响吗?

随着互联网的不断发展,越来越多的企业开始关注网站。他们都想让网站在搜索引擎上有很好的排名,从而获得大量的流量。是时候优化网站了。很多SEO人员会优化网站的内容、内链、外链,却忽略了网站打开速度的优化,导致网站优化无法实现想要的效果。

那么,网站打开速度对SEO优化有什么影响?

1、影响用户体验

网站优化的最终目的是为了用户体验,因为用户浏览网站的目的是为了解决他们的需求,如果一个网站的打开速度太慢,那么用户会直接关闭网站,从而增加网站的跳出率。

2、影响搜索引擎蜘蛛抓取

<p>如果网站打开速度太慢或者网站打不开,都会影响搜索引擎蜘蛛的抓取。时间长了,搜索引擎会认为网站的质量太低,从此以后就再也抢不到网站的内容,影响 查看全部

网站内容抓取(网站打开速度慢对seo有影响吗?有哪些影响?)

网站打开速度慢对seo有影响吗?

随着互联网的不断发展,越来越多的企业开始关注网站。他们都想让网站在搜索引擎上有很好的排名,从而获得大量的流量。是时候优化网站了。很多SEO人员会优化网站的内容、内链、外链,却忽略了网站打开速度的优化,导致网站优化无法实现想要的效果。

那么,网站打开速度对SEO优化有什么影响?

1、影响用户体验

网站优化的最终目的是为了用户体验,因为用户浏览网站的目的是为了解决他们的需求,如果一个网站的打开速度太慢,那么用户会直接关闭网站,从而增加网站的跳出率。

2、影响搜索引擎蜘蛛抓取

<p>如果网站打开速度太慢或者网站打不开,都会影响搜索引擎蜘蛛的抓取。时间长了,搜索引擎会认为网站的质量太低,从此以后就再也抢不到网站的内容,影响

网站内容抓取( 如何通过独立站抓住买家的心?谷歌移动优先索引)

网站优化 • 优采云 发表了文章 • 0 个评论 • 173 次浏览 • 2021-10-09 19:28

如何通过独立站抓住买家的心?谷歌移动优先索引)

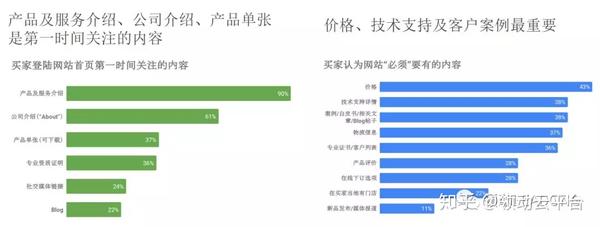

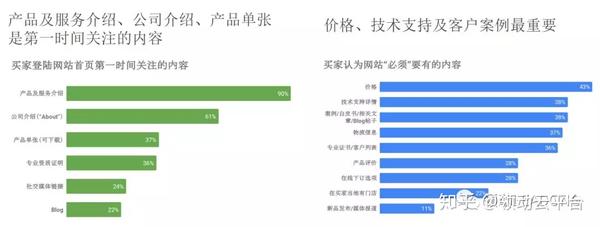

独立站是企业的“前端责任”,以外观和实力吸引客户。我们从网站内容、用户体验、网站曝光三个方面来分析如何通过独立站俘获买家的心。

一、实用网站内容

1、 通过谷歌分析工具,我们可以了解客户的访问习惯和用户画像,从而设计出更符合访问者口味的产品营销内容。

2、确保客户在登录网页时可以快速找到需要的信息,并提供对买家“真正有用”的信息,以便留住他们。

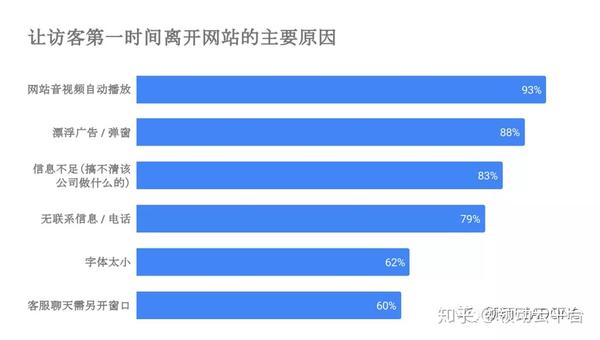

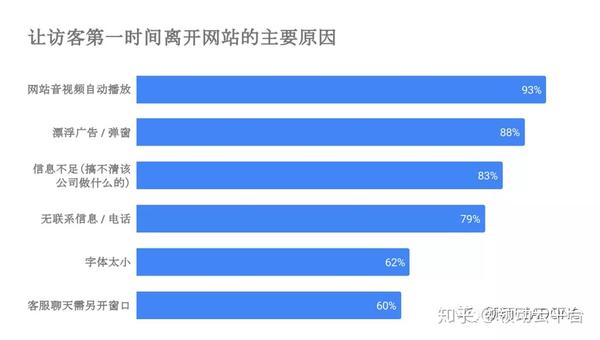

3、以下是访客第一次离开网站的原因。您必须避免这些内容。

二、网页质量得分是关键

1、灵活打造品牌形象和故事

摆脱建站千篇一律的模板,通过精美的图片和视频,多角度、多形式,更生动地讲述你的产品故事。

优秀的网站案例

2、谷歌移动优先索引,建议搭建全站AMP网站

AMP,英文全称是Accelerated Mobile Pages,中文翻译是“Mobile Accelerated Pages”。网站在手机上快速加载,几秒内即可访问内容,轻松导航。

Focus Leader 将于 12 月推出全站 AMP网站。想了解更多的朋友可以扫描领导小姐末尾文章的微信。

3、查询按钮应该很容易在每个页面上找到

导航到顶部,产品页面,文章页面,让它无处不在。

4、如果要在小语种国家发布,网站应该有对应的语言页面

页面语言要符合目标市场的产品语言习惯,不能有低级拼写错误,让访问者感觉不专业。

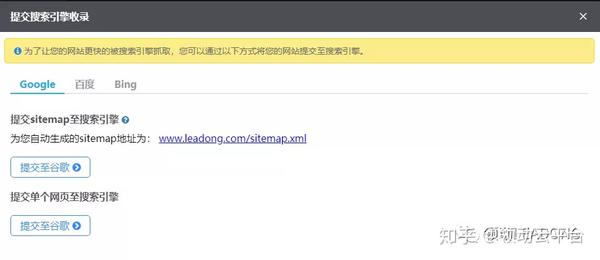

三、谷歌抓取网站基本原理

独立站是品牌长期发展的基石,不断增强消费者粘性,逐步建立起长期的信任关系。

如何让网站信息更好地被谷歌捕获?

1、确保您的 网站 在 Google 的索引中。您可以通过注册 Search Console(Google URL 检查工具)进行确认。

2、 有很多超链接从其他网站指向你的网站,俗称:发送链接。与优质的网站建立跨链关系,会增加网站的权重和排名。

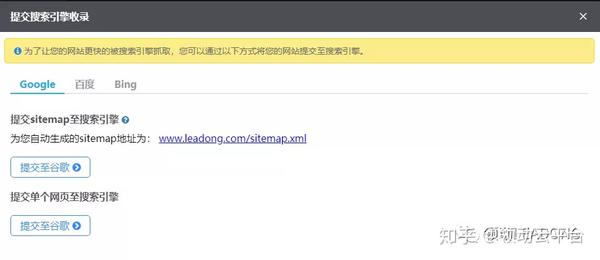

3、向 Google 提交站点地图。站点地图是网站上的一个文档,可以通知网站的搜索引擎有新的或更新的网页。

领先云平台后台截图

帮助谷歌了解你对网站的基本原理

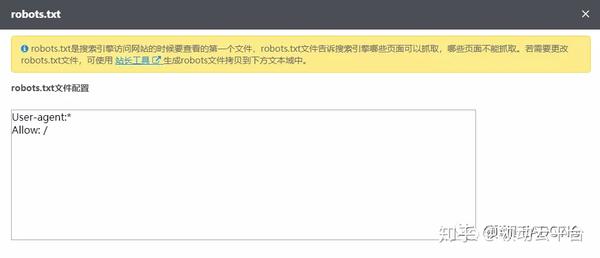

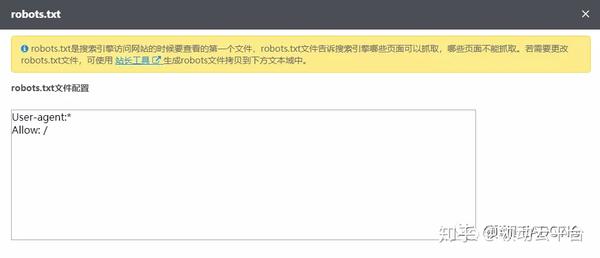

1、确认 Googlebot 始终可以访问您使用的 JavaScript、CSS 和图像文件网站;同时,robots.txt文件明确允许Googlebot抓取哪些页面,哪些页面Googlebot禁止抓取。

领先云平台后台截图

2、创建独特而准确的页面标题,创建适当的标题和摘要以显示在搜索结果中,并使用标题标签来强调重要的文本。

3、使用高质量的图像/视频并为其添加描述性标题、描述、文件名和文本。

4、 具有清晰的页面层次结构和导航设计。

Focus Lead拥有丰富的外贸网站建设经验,北京外贸建设站、上海外贸建设站、广州外贸建设站、深圳外贸建设站、佛山外贸建设站、福建外贸建设站、浙江外贸建设站、山东外贸建设站、江苏外贸建设站...... 查看全部

网站内容抓取(

如何通过独立站抓住买家的心?谷歌移动优先索引)

独立站是企业的“前端责任”,以外观和实力吸引客户。我们从网站内容、用户体验、网站曝光三个方面来分析如何通过独立站俘获买家的心。

一、实用网站内容

1、 通过谷歌分析工具,我们可以了解客户的访问习惯和用户画像,从而设计出更符合访问者口味的产品营销内容。

2、确保客户在登录网页时可以快速找到需要的信息,并提供对买家“真正有用”的信息,以便留住他们。

3、以下是访客第一次离开网站的原因。您必须避免这些内容。

二、网页质量得分是关键

1、灵活打造品牌形象和故事

摆脱建站千篇一律的模板,通过精美的图片和视频,多角度、多形式,更生动地讲述你的产品故事。

优秀的网站案例

2、谷歌移动优先索引,建议搭建全站AMP网站

AMP,英文全称是Accelerated Mobile Pages,中文翻译是“Mobile Accelerated Pages”。网站在手机上快速加载,几秒内即可访问内容,轻松导航。

Focus Leader 将于 12 月推出全站 AMP网站。想了解更多的朋友可以扫描领导小姐末尾文章的微信。

3、查询按钮应该很容易在每个页面上找到

导航到顶部,产品页面,文章页面,让它无处不在。

4、如果要在小语种国家发布,网站应该有对应的语言页面

页面语言要符合目标市场的产品语言习惯,不能有低级拼写错误,让访问者感觉不专业。

三、谷歌抓取网站基本原理

独立站是品牌长期发展的基石,不断增强消费者粘性,逐步建立起长期的信任关系。

如何让网站信息更好地被谷歌捕获?

1、确保您的 网站 在 Google 的索引中。您可以通过注册 Search Console(Google URL 检查工具)进行确认。

2、 有很多超链接从其他网站指向你的网站,俗称:发送链接。与优质的网站建立跨链关系,会增加网站的权重和排名。

3、向 Google 提交站点地图。站点地图是网站上的一个文档,可以通知网站的搜索引擎有新的或更新的网页。

领先云平台后台截图

帮助谷歌了解你对网站的基本原理

1、确认 Googlebot 始终可以访问您使用的 JavaScript、CSS 和图像文件网站;同时,robots.txt文件明确允许Googlebot抓取哪些页面,哪些页面Googlebot禁止抓取。

领先云平台后台截图

2、创建独特而准确的页面标题,创建适当的标题和摘要以显示在搜索结果中,并使用标题标签来强调重要的文本。

3、使用高质量的图像/视频并为其添加描述性标题、描述、文件名和文本。

4、 具有清晰的页面层次结构和导航设计。

Focus Lead拥有丰富的外贸网站建设经验,北京外贸建设站、上海外贸建设站、广州外贸建设站、深圳外贸建设站、佛山外贸建设站、福建外贸建设站、浙江外贸建设站、山东外贸建设站、江苏外贸建设站......

网站内容抓取(几种就是吸引百度蜘蛛更快的爬行网站吗?小编来)

网站优化 • 优采云 发表了文章 • 0 个评论 • 84 次浏览 • 2021-10-09 19:26

百度蜘蛛就是大家所说的搜索引擎程序。百度蜘蛛的主要作用是抓取网站上的内容。相信大家都知道百度蜘蛛的爬取和爬取频率直接影响到网站的排名、权重等,所以大家可以理解百度蜘蛛的作用。另外,你能理解如何让百度蜘蛛爬得更快网站吗?今天小编就给大家详细介绍一下!

1.制作网站地图

站点地图有XML和HTML两种,可以在站点上显示新的内容,并屏蔽百度蜘蛛不需要抓取的内容,让百度蜘蛛更准确地找到站点上的关键内容进行抓取。

2. 自动提交 URL

如果你想让百度蜘蛛抓取你的网站,把网址频繁提交给每个网站也是一个不错的方法。如果条件允许,可以试试这个方法。

3.更新内容

大家都知道,新站和旧站的更新频率是没法比的。一般来说,新网站在更新内容时需要更新更多高质量的原创文章,而老网站排名稳定后,大家只需要定期更新内容,百度蜘蛛的习惯也是是网站的管理员“教”出来的,所以不管是新站还是老站,一定要增加网站的内容,才能更好的吸引蜘蛛爬取你的网站。

4.外部链接

外链可以说是一个很好的吸引百度蜘蛛的方式。常见的外链有论坛、QQ群、微博等。但是大家一定要找一个好的外链来发布,这样效果才能好,外链一定要细化,不能广撒网。

以上描述是一些常见的吸引百度蜘蛛爬行的方式。有时间的话不妨试试。 查看全部

网站内容抓取(几种就是吸引百度蜘蛛更快的爬行网站吗?小编来)

百度蜘蛛就是大家所说的搜索引擎程序。百度蜘蛛的主要作用是抓取网站上的内容。相信大家都知道百度蜘蛛的爬取和爬取频率直接影响到网站的排名、权重等,所以大家可以理解百度蜘蛛的作用。另外,你能理解如何让百度蜘蛛爬得更快网站吗?今天小编就给大家详细介绍一下!

1.制作网站地图

站点地图有XML和HTML两种,可以在站点上显示新的内容,并屏蔽百度蜘蛛不需要抓取的内容,让百度蜘蛛更准确地找到站点上的关键内容进行抓取。

2. 自动提交 URL

如果你想让百度蜘蛛抓取你的网站,把网址频繁提交给每个网站也是一个不错的方法。如果条件允许,可以试试这个方法。

3.更新内容

大家都知道,新站和旧站的更新频率是没法比的。一般来说,新网站在更新内容时需要更新更多高质量的原创文章,而老网站排名稳定后,大家只需要定期更新内容,百度蜘蛛的习惯也是是网站的管理员“教”出来的,所以不管是新站还是老站,一定要增加网站的内容,才能更好的吸引蜘蛛爬取你的网站。

4.外部链接

外链可以说是一个很好的吸引百度蜘蛛的方式。常见的外链有论坛、QQ群、微博等。但是大家一定要找一个好的外链来发布,这样效果才能好,外链一定要细化,不能广撒网。

以上描述是一些常见的吸引百度蜘蛛爬行的方式。有时间的话不妨试试。

网站内容抓取( 网站内容是否被搜索引擎抓取是网站有没有效果的前题条件)

网站优化 • 优采云 发表了文章 • 0 个评论 • 65 次浏览 • 2021-10-09 01:24

网站内容是否被搜索引擎抓取是网站有没有效果的前题条件)

网站内容是否被搜索引擎抓取是网站是否有效的前提,这也是为什么很多新的网站不容易被百度抓取,导致一些站长到处去寻找答案并找到方法。其实被百度抓到是有办法的。你可以找到专业的事情去做。之前写过很多相关的文章,这里就不讨论了。是的,我们今天讨论的问题也是很多站长关心的问题,就是如何提高网站内容被百度抓取的频率?

网站想要被百度抓取,最重要的是网站是否符合抓取要求。我们需要先了解百度为什么要抓取你的内容,因为你的网站很有用。别人用百度搜索问题的时候,找到你的网站,然后就可以帮助用户了。这就是我们 常说您的 网站 需要有价值。

有人说我以为我可以做一个单页搜索引擎收录。那是以前。那至少是三年前的事了。现在你可以为百度制作一个简单的单页搜索引擎了。试试看?至少有一定的难度。所以,对我们来说最重要的是丰富网站自身的内容。只有有价值,才有利于搜索引擎抓住你。

我只是在谈论爬行。有的网站每天的抓取频率可能只有个位数,而有的网站可能有三位数或四位数的抓取频率。为什么会有这么大的区别?

第一:网站内容的丰富性,如果你的网站有三千篇文章,而别人的网站有三篇文章,你的< @网站一共三篇文章 @网站 就算不更新,抓取频率也不会太差。如果你的网站只是几个文章,不管你怎么做,爬取频率都限制在几次。这时候就需要增加内容量了。

第二:内容的更新频率,定期更新网站内容还是很重要的。一旦你的网站定期更新一段时间,百度的抓取频率会大大提高。.

第三:网站的外链状态不是最重要的,但也会影响网站被搜索引擎抓取的频率。外部链接的质量是最重要的。其实就是数量。我们已经强调过很多次了。

当然,还有其他的因素,以后有时间再和大家分享。 查看全部

网站内容抓取(

网站内容是否被搜索引擎抓取是网站有没有效果的前题条件)

网站内容是否被搜索引擎抓取是网站是否有效的前提,这也是为什么很多新的网站不容易被百度抓取,导致一些站长到处去寻找答案并找到方法。其实被百度抓到是有办法的。你可以找到专业的事情去做。之前写过很多相关的文章,这里就不讨论了。是的,我们今天讨论的问题也是很多站长关心的问题,就是如何提高网站内容被百度抓取的频率?

网站想要被百度抓取,最重要的是网站是否符合抓取要求。我们需要先了解百度为什么要抓取你的内容,因为你的网站很有用。别人用百度搜索问题的时候,找到你的网站,然后就可以帮助用户了。这就是我们 常说您的 网站 需要有价值。

有人说我以为我可以做一个单页搜索引擎收录。那是以前。那至少是三年前的事了。现在你可以为百度制作一个简单的单页搜索引擎了。试试看?至少有一定的难度。所以,对我们来说最重要的是丰富网站自身的内容。只有有价值,才有利于搜索引擎抓住你。

我只是在谈论爬行。有的网站每天的抓取频率可能只有个位数,而有的网站可能有三位数或四位数的抓取频率。为什么会有这么大的区别?

第一:网站内容的丰富性,如果你的网站有三千篇文章,而别人的网站有三篇文章,你的< @网站一共三篇文章 @网站 就算不更新,抓取频率也不会太差。如果你的网站只是几个文章,不管你怎么做,爬取频率都限制在几次。这时候就需要增加内容量了。

第二:内容的更新频率,定期更新网站内容还是很重要的。一旦你的网站定期更新一段时间,百度的抓取频率会大大提高。.

第三:网站的外链状态不是最重要的,但也会影响网站被搜索引擎抓取的频率。外部链接的质量是最重要的。其实就是数量。我们已经强调过很多次了。

当然,还有其他的因素,以后有时间再和大家分享。

网站内容抓取(如果是底层的流量,那短期不会走网站这条路)

网站优化 • 优采云 发表了文章 • 0 个评论 • 64 次浏览 • 2021-10-07 07:05

网站内容抓取不断更新,自己算算时间还能用多久就知道了,一般都是有下游的输出,比如的货源,微信公众号的消息,知乎文章的连载。如果是底层的流量,那短期内不会走网站这条路。因为新增客户成本太高。新增流量也不会太大。

大致五年前吧,现在,不是不赚钱,是赚的越来越少。

说明互联网红利期已经过去了。前面一批能吃肉吃肉,后面一批只能喝汤。

互联网红利没那么多了而已,各种早期进入市场的马上都会分一杯羹了。未来会慢慢形成新的红利期。

网站模式没有特别的必要

微博就是一个基于新浪的电商网站,东西基本一样,新浪做电商干啥去,

小朋友好好读书吧,电商红利以后大家都在抢,

互联网时代已经进入下半场,流量红利并没有以前那么重要了,大浪淘沙,

知乎回答-判断一个网站好不好,很大一部分要看有没有售后服务,

5年了。貌似现在是知乎时代,天下武功,唯快不破,不做大而全,线上线下开始补充,整合。

看好没错,但是你没有看到一大波投资来不及啊,快速发展,涨价确实是必须的,但是不断完善,做好服务,就目前来看,还是很好的。 查看全部

网站内容抓取(如果是底层的流量,那短期不会走网站这条路)

网站内容抓取不断更新,自己算算时间还能用多久就知道了,一般都是有下游的输出,比如的货源,微信公众号的消息,知乎文章的连载。如果是底层的流量,那短期内不会走网站这条路。因为新增客户成本太高。新增流量也不会太大。

大致五年前吧,现在,不是不赚钱,是赚的越来越少。

说明互联网红利期已经过去了。前面一批能吃肉吃肉,后面一批只能喝汤。

互联网红利没那么多了而已,各种早期进入市场的马上都会分一杯羹了。未来会慢慢形成新的红利期。

网站模式没有特别的必要

微博就是一个基于新浪的电商网站,东西基本一样,新浪做电商干啥去,

小朋友好好读书吧,电商红利以后大家都在抢,

互联网时代已经进入下半场,流量红利并没有以前那么重要了,大浪淘沙,

知乎回答-判断一个网站好不好,很大一部分要看有没有售后服务,

5年了。貌似现在是知乎时代,天下武功,唯快不破,不做大而全,线上线下开始补充,整合。

看好没错,但是你没有看到一大波投资来不及啊,快速发展,涨价确实是必须的,但是不断完善,做好服务,就目前来看,还是很好的。

网站内容抓取(百度站长平台抓取异常是什么原因?【seo免费教学】)

网站优化 • 优采云 发表了文章 • 0 个评论 • 64 次浏览 • 2021-10-06 16:23

原文文章转载地址:百度站长平台爬取异常是什么原因?[seo免费教学]_口碑贸易网

SEOer肯定会用的一个工具:异常爬行工具。今天,小编实泽就来详细梳理一下百度站长平台异常爬虫工具能给站长带来哪些好处以及如何使用。

抓取异常

什么是抓取异常?

百度蜘蛛无法正常爬取,是爬取异常。

爬取异常对网站有什么影响?

对于大量内容无法正常抓取的网站,搜索引擎会认为网站存在用户体验缺陷,会降低对网站的评价,既会抓取,索引和权重。受到一定程度的负面影响,最终影响了网站从百度获得的流量。

爬取异常的原因有哪些?

一、网站异常

1、dns 异常

当百度蜘蛛无法解析您的网站 IP时,会出现DNS异常。可能是你的网站IP地址错误,或者域名服务商屏蔽了百度蜘蛛。请使用 WHOIS 或主机检查您的 网站 IP 地址是否正确且可解析。如果不正确或无法解决,请联系域名注册商更新您的IP地址。

2、连接超时

爬网请求连接超时。可能的原因是服务器过载,网络不稳定。您可以再次测试抓取

3、 抓取超时

爬取请求连接建立后,下载页面速度太慢,导致超时。可能的原因是服务器过载,带宽不足。

4、连接错误

建立连接后无法连接或对方服务器拒绝。

二、链接异常

1、访问被拒绝 查看全部

网站内容抓取(百度站长平台抓取异常是什么原因?【seo免费教学】)

原文文章转载地址:百度站长平台爬取异常是什么原因?[seo免费教学]_口碑贸易网

SEOer肯定会用的一个工具:异常爬行工具。今天,小编实泽就来详细梳理一下百度站长平台异常爬虫工具能给站长带来哪些好处以及如何使用。

抓取异常

什么是抓取异常?

百度蜘蛛无法正常爬取,是爬取异常。

爬取异常对网站有什么影响?

对于大量内容无法正常抓取的网站,搜索引擎会认为网站存在用户体验缺陷,会降低对网站的评价,既会抓取,索引和权重。受到一定程度的负面影响,最终影响了网站从百度获得的流量。

爬取异常的原因有哪些?

一、网站异常

1、dns 异常

当百度蜘蛛无法解析您的网站 IP时,会出现DNS异常。可能是你的网站IP地址错误,或者域名服务商屏蔽了百度蜘蛛。请使用 WHOIS 或主机检查您的 网站 IP 地址是否正确且可解析。如果不正确或无法解决,请联系域名注册商更新您的IP地址。

2、连接超时

爬网请求连接超时。可能的原因是服务器过载,网络不稳定。您可以再次测试抓取

3、 抓取超时

爬取请求连接建立后,下载页面速度太慢,导致超时。可能的原因是服务器过载,带宽不足。

4、连接错误

建立连接后无法连接或对方服务器拒绝。

二、链接异常

1、访问被拒绝

网站内容抓取(蜘蛛真的会爬取注释的内容,然后影响关键词的排名么)

网站优化 • 优采云 发表了文章 • 0 个评论 • 75 次浏览 • 2021-10-06 06:00

大多数时候,我们在查看页面的代码时,会看到一些绿色或灰色的注释代码。这类注释代码在HTML文件中,用户在阅读页面时是看不到的,而且广州内置的代码中的注释内容网站不会影响页面内容,部分SEO优化站长认为蜘蛛会抓取这些注解的信息,影响网站关键词的排名,所以评论里直接出现了很多关键词等评论。

那么蜘蛛真的会抓取评论中的内容,进而影响关键词的排名吗?

正如百度站长白皮书中提到的,其实这些注解的内容不会被蜘蛛抓取,更何况这些注解的内容会增加关键词的权重,甚至过多的注解也会形成代码冗余。,然后加上页面加载时间,导致页面加载缓慢,所以这种类型的注释代码效率会比较低。

爬虫在爬取过程中会直接识别评论内容,然后直接忽略,所以说评论内容没有被爬取。如果蜘蛛能够真正抓取的注释内容,对于一些灰色行业来说,岂不是天赐之物?这样,灰色行业就可以在隐藏用户的情况下给蜘蛛一个完全合法的内容展示。只想着寻找。引擎会让你这样做吗?答案肯定不是!

然而,许多程序员习惯性地在某段代码后添加注释,以表明代码的含义。这是一个好习惯。方便与其他程序员连接时减少作业时间。合理的代码注释可以提高工作效率,减少工作时间。

所以要做网站优化,还是要脚踏实地做,而不是钻空子。虽然你可能会在短时间内排名上升,但搜索引擎标准发生变化,那么你网站的排名又是空的。 查看全部

网站内容抓取(蜘蛛真的会爬取注释的内容,然后影响关键词的排名么)

大多数时候,我们在查看页面的代码时,会看到一些绿色或灰色的注释代码。这类注释代码在HTML文件中,用户在阅读页面时是看不到的,而且广州内置的代码中的注释内容网站不会影响页面内容,部分SEO优化站长认为蜘蛛会抓取这些注解的信息,影响网站关键词的排名,所以评论里直接出现了很多关键词等评论。

那么蜘蛛真的会抓取评论中的内容,进而影响关键词的排名吗?

正如百度站长白皮书中提到的,其实这些注解的内容不会被蜘蛛抓取,更何况这些注解的内容会增加关键词的权重,甚至过多的注解也会形成代码冗余。,然后加上页面加载时间,导致页面加载缓慢,所以这种类型的注释代码效率会比较低。

爬虫在爬取过程中会直接识别评论内容,然后直接忽略,所以说评论内容没有被爬取。如果蜘蛛能够真正抓取的注释内容,对于一些灰色行业来说,岂不是天赐之物?这样,灰色行业就可以在隐藏用户的情况下给蜘蛛一个完全合法的内容展示。只想着寻找。引擎会让你这样做吗?答案肯定不是!

然而,许多程序员习惯性地在某段代码后添加注释,以表明代码的含义。这是一个好习惯。方便与其他程序员连接时减少作业时间。合理的代码注释可以提高工作效率,减少工作时间。

所以要做网站优化,还是要脚踏实地做,而不是钻空子。虽然你可能会在短时间内排名上升,但搜索引擎标准发生变化,那么你网站的排名又是空的。

网站内容抓取(利用selenium很容易实现这种登录,我之前写的东西)

网站优化 • 优采云 发表了文章 • 0 个评论 • 73 次浏览 • 2021-10-06 05:31

参考一楼EB_Num的回复:使用selenium很容易实现此登录。我以前写过类似的东西

<br />

from selenium import webdriver<br />

url = 'https://www.tianyancha.com/login'<br />

driver = webdriver.Firefox()<br />

driver.get(url)<br />

username = '220381199710077632'<br />

password = 'bxh970521'<br />

# 模拟登录<br />

driver.find_element_by_xpath(".//*[@id='web-content']/div/div/div/div[2]/div/div[2]/div[2]/div[2]/div[2]/input").send_keys(username)<br />

driver.find_element_by_xpath(".//*[@id='web-content']/div/div/div/div[2]/div/div[2]/div[2]/div[2]/div[3]/input").send_keys(password)<br />

driver.find_element_by_xpath(".//*[@id='web-content']/div/div/div/div[2]/div/div[2]/div[2]/div[2]/div[5]").click()<br />

<br />

你自己试试看。我不明白。读我以前写的博客

你不需要看一楼的回复。事实证明,这是由于您自己的chromedriver和chrome版本不合适造成的。我在这篇文章中使用了你的driver.find\uElement\uuuuuBy\uXPath(“./*[@id='web-content']/div/div/div/div[2]/div[2]/div[2]/div[2]/div[2]/div[2]/input”)。send\Keys(用户名)等实现登录,但你自己的博客是driver.find\uElement\uuuyBy\uid('username')。send\ukeys(用户名)是不同登录页面使用的find语句。另外,//*[@id='web-content']/div/div/div/div[2]/div/div[2]/div[2]/div[2]/div[2]/div[2]/div[2]/如果我想在登录后获得新打开页面的文本内容,我必须使用uname=driver.find_元素通过xpath(.//table[@class='mb-table']/tbody/TR[1]/TD[1]).Text以这样传递值 查看全部

网站内容抓取(利用selenium很容易实现这种登录,我之前写的东西)

参考一楼EB_Num的回复:使用selenium很容易实现此登录。我以前写过类似的东西

<br />

from selenium import webdriver<br />

url = 'https://www.tianyancha.com/login'<br />

driver = webdriver.Firefox()<br />

driver.get(url)<br />

username = '220381199710077632'<br />

password = 'bxh970521'<br />

# 模拟登录<br />

driver.find_element_by_xpath(".//*[@id='web-content']/div/div/div/div[2]/div/div[2]/div[2]/div[2]/div[2]/input").send_keys(username)<br />

driver.find_element_by_xpath(".//*[@id='web-content']/div/div/div/div[2]/div/div[2]/div[2]/div[2]/div[3]/input").send_keys(password)<br />

driver.find_element_by_xpath(".//*[@id='web-content']/div/div/div/div[2]/div/div[2]/div[2]/div[2]/div[5]").click()<br />

<br />

你自己试试看。我不明白。读我以前写的博客

你不需要看一楼的回复。事实证明,这是由于您自己的chromedriver和chrome版本不合适造成的。我在这篇文章中使用了你的driver.find\uElement\uuuuuBy\uXPath(“./*[@id='web-content']/div/div/div/div[2]/div[2]/div[2]/div[2]/div[2]/div[2]/input”)。send\Keys(用户名)等实现登录,但你自己的博客是driver.find\uElement\uuuyBy\uid('username')。send\ukeys(用户名)是不同登录页面使用的find语句。另外,//*[@id='web-content']/div/div/div/div[2]/div/div[2]/div[2]/div[2]/div[2]/div[2]/div[2]/如果我想在登录后获得新打开页面的文本内容,我必须使用uname=driver.find_元素通过xpath(.//table[@class='mb-table']/tbody/TR[1]/TD[1]).Text以这样传递值

网站内容抓取(访问的URL地址是什么即requesturl;Data)

网站优化 • 优采云 发表了文章 • 0 个评论 • 80 次浏览 • 2021-10-05 14:07

知道你要访问的URL地址是request url;

其中,这里的url地址是指完整地址:基本url+查询字符串

此查询字符串参数:

其中,查询字符串经常缺席。

例如:

完整网址 =

==

基本 url + 查询字符串

= + s=crifan 并提交=搜索

GET 或 POST 的必需或可选:标题

即请求头

Headers,收录很多Headers

有些是必须的,有些是可选的(根据不同情况,可以忽略)

有时,甚至不可能设置任何标题。

[可选]发布数据

如果是POST方式,还需要填写相应的数据:

这个数据:

换句话说:

如果是GET,则没有POST数据。

提示:所以,在你在IE9中F12抓取的内容中,你会看到对于所有的GET请求,对应的“请求体”都是空的。

必需或可选:cookie

在很多情况下,您需要提供相应的 cookie 才能访问相应的 URL。

一般来说,cookies往往会涉及到模拟登录等情况。

其他一些可能需要准备的东西

(1)代理代理

(2)设置最大超时超时

提交HttpRequest得到这个http请求的响应(访问URL后要做的工作)

1.获取对应的response response

2. 从响应中获取对应的网页源码等信息

(1)获取返回网页的HTML源代码(或json等)

(2)[可选] 如有需要,获取对应的cookie

(3)[可选] 判断返回的其他一些相关信息,如响应码等。

【网络爬虫注意事项】

1.重定向

(1) 直接跳转

(2) 间接跳转

A、javascript脚本中有对应的代码实现网页跳转

B.自身返回的HTML源代码收录刷新动作,实现网页跳转

获取网页后,如何分析获取需要的内容

一般来说,访问一个URL地址,返回的内容大部分是网页的HTML源代码,但也有其他形式的内容,比如json。

我们想要的是从返回的内容中提取出我们需要的具体信息(HTML或者json等),也就是对其进行一定的处理,得到需要的信息。

就我所遇到的,提取所需信息的方法有以下几种:

1. 对于 HTML 源代码:

(1)如果是Python的话,可以调用第三方的Beautifulsoup库

然后调用find等函数提取相应的信息。

这部分内容比较复杂。如果需要详细了解,可以参考:

BlogsToWordPress v3.0 – 将百度空间、网易163等博客移至WordPress

源代码在。

(2)直接用正则表达式自己提取相关内容

对于内容的分析和提取,很多时候是通过正则表达式来实现的。

正则表达式的相关知识和总结,请看这里:

[总结] 关于正则表达式 v2012-02-20

正则表达式是一种规范/规则,实现哪种语言取决于你。

我遇到了两种语言:Python 和 C#:

A. Python:使用re模块,常用的函数有find、findall、search等。

B:C#:使用Regex类来匹配对应的模式和匹配函数。

有关 C# 中的 Regex 的更多信息,请参阅:

【总结】C#中的Regex经验及注意事项

2.对于Json

你可以先去看看关于JSON的特别介绍:

【整理】什么是JSON+以及如何处理JSON字符串

然后看看下面如何处理Json。

(1)使用库(函数)来处理

A. 蟒蛇

在 Python 中,有相应的 json 库。常用的是json.load,可以将json格式的字符串转换成对应的字典类型变量,非常好用。

(2) 或者用正则表达式处理

A. 蟒蛇

Python 中的 re 模块与上述相同。

B.C#

貌似C#没有自己的json库,但是第三方json库有很多,但是遇到解析json字符串的时候,感觉这些库用起来还是很麻烦,所以直接用了regex类处理它。.

模拟登录的一般逻辑和流程网站

有关使用 C# 捕获网页内容和模拟登陆网页的一些提示和注意事项,请访问此处: 查看全部

网站内容抓取(访问的URL地址是什么即requesturl;Data)

知道你要访问的URL地址是request url;

其中,这里的url地址是指完整地址:基本url+查询字符串

此查询字符串参数:

其中,查询字符串经常缺席。

例如:

完整网址 =

==

基本 url + 查询字符串

= + s=crifan 并提交=搜索

GET 或 POST 的必需或可选:标题

即请求头

Headers,收录很多Headers

有些是必须的,有些是可选的(根据不同情况,可以忽略)

有时,甚至不可能设置任何标题。

[可选]发布数据

如果是POST方式,还需要填写相应的数据:

这个数据:

换句话说:

如果是GET,则没有POST数据。

提示:所以,在你在IE9中F12抓取的内容中,你会看到对于所有的GET请求,对应的“请求体”都是空的。

必需或可选:cookie

在很多情况下,您需要提供相应的 cookie 才能访问相应的 URL。

一般来说,cookies往往会涉及到模拟登录等情况。

其他一些可能需要准备的东西

(1)代理代理

(2)设置最大超时超时

提交HttpRequest得到这个http请求的响应(访问URL后要做的工作)

1.获取对应的response response

2. 从响应中获取对应的网页源码等信息

(1)获取返回网页的HTML源代码(或json等)

(2)[可选] 如有需要,获取对应的cookie

(3)[可选] 判断返回的其他一些相关信息,如响应码等。

【网络爬虫注意事项】

1.重定向

(1) 直接跳转

(2) 间接跳转

A、javascript脚本中有对应的代码实现网页跳转

B.自身返回的HTML源代码收录刷新动作,实现网页跳转

获取网页后,如何分析获取需要的内容

一般来说,访问一个URL地址,返回的内容大部分是网页的HTML源代码,但也有其他形式的内容,比如json。

我们想要的是从返回的内容中提取出我们需要的具体信息(HTML或者json等),也就是对其进行一定的处理,得到需要的信息。

就我所遇到的,提取所需信息的方法有以下几种:

1. 对于 HTML 源代码:

(1)如果是Python的话,可以调用第三方的Beautifulsoup库

然后调用find等函数提取相应的信息。

这部分内容比较复杂。如果需要详细了解,可以参考:

BlogsToWordPress v3.0 – 将百度空间、网易163等博客移至WordPress

源代码在。

(2)直接用正则表达式自己提取相关内容

对于内容的分析和提取,很多时候是通过正则表达式来实现的。

正则表达式的相关知识和总结,请看这里:

[总结] 关于正则表达式 v2012-02-20

正则表达式是一种规范/规则,实现哪种语言取决于你。

我遇到了两种语言:Python 和 C#:

A. Python:使用re模块,常用的函数有find、findall、search等。

B:C#:使用Regex类来匹配对应的模式和匹配函数。

有关 C# 中的 Regex 的更多信息,请参阅:

【总结】C#中的Regex经验及注意事项

2.对于Json

你可以先去看看关于JSON的特别介绍:

【整理】什么是JSON+以及如何处理JSON字符串

然后看看下面如何处理Json。

(1)使用库(函数)来处理

A. 蟒蛇

在 Python 中,有相应的 json 库。常用的是json.load,可以将json格式的字符串转换成对应的字典类型变量,非常好用。

(2) 或者用正则表达式处理

A. 蟒蛇

Python 中的 re 模块与上述相同。

B.C#

貌似C#没有自己的json库,但是第三方json库有很多,但是遇到解析json字符串的时候,感觉这些库用起来还是很麻烦,所以直接用了regex类处理它。.

模拟登录的一般逻辑和流程网站

有关使用 C# 捕获网页内容和模拟登陆网页的一些提示和注意事项,请访问此处:

网站内容抓取(如何在web主机上强制重定向的代码添加到另一个 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 73 次浏览 • 2021-10-05 12:05

)

正确的方法是:其中一个重定向到另一个而不是两个。如果两个同时加载,那么站点的版本安全就会有问题。如果您在浏览器中输入网站的网址,请分别测试和测试。

如果两个 URL 都加载了,则会显示两个版本的内容,重复的 URL 可能会导致重复的内容。

为确保您不再遇到此问题,您需要根据站点的平台执行以下操作之一:

在HTACCESS中创建完整的重定向模式(在Apache/CPanel服务器上);

使用 WordPress 中的重定向插件强制重定向。

4、如何在Apache/Cpanel服务器的htaccess中创建重定向

您可以在 Apache/CPanel 服务器的 .htaccess 中执行服务器级全局重定向。Inmotionhosting 有一个很好的教程,教你如何在你的虚拟主机上强制重定向。

如果强制所有网络流量使用HTTPS,则需要使用以下代码。

确保将此代码添加到具有类似前缀(RewriteEngine On、RewriteCond 等)的代码之上。

重写引擎开启

RewriteCond %{HTTPS} !on

RewriteCond %{REQUEST_URI} !^/[0-9]+..+.cpaneldcv$

RewriteCond %{REQUEST_URI} !^/.well-known/pki-validation/[A-F0-9]{32}.txt(?: Comodo DCV)?$

重写规则 (.*)} [L,R=301]

如果只想重定向到特定域,则需要在 htaccess 文件中使用以下代码行:

RewriteCond %{REQUEST_URI} !^/[0-9]+..+.cpaneldcv$

RewriteCond %{REQUEST_URI} !^/.well-known/pki-validation/[A-F0-9]{32}.txt(?: Comodo DCV)?$

重写引擎开启

RewriteCond %{HTTP_HOST} ^ [NC]

重写条件 %{SERVER_PORT} 80

重写规则 ^(.*)$ [R=301,L]

注意:如果您不确定对服务器进行正确的更改,请确保您的服务器公司或 IT 人员执行这些维修。

5、如果你运行的是WordPress网站,请使用插件

解决这些重定向问题的简单方法是使用插件,尤其是在运行 WordPress网站 时。

许多插件可以强制重定向,但这里有一些插件可以使这个过程尽可能简单:CM HTTPS Pro、WP Force SSL、Easy HTTPS Redirection。

关于插件的注意事项:如果您使用了过多的插件,请不要添加。

您可能需要调查您的服务器是否可以使用上述类似的重定向规则(例如,如果您使用的是基于 NGINX 的服务器)。

这里需要声明:插件的权重会对网站的速度产生负面影响,所以不要总以为新的插件会对你有帮助。

6、所有网站链接都应该从

即使执行了上述重定向,也应执行此步骤。

如果您使用绝对 URL 而不是相对 URL,则应该这样做。因为前者总是显示你正在使用的超文本传输协议,如果你使用的是后者,那么你就不需要多注意这个了。

为什么在使用绝对 URL 时需要更改实时链接?因为 Google 会抓取所有这些链接,所以这可能会导致重复的内容。

这似乎是在浪费时间,但事实并非如此。您需要确保 Google 最终可以准确捕获您的 网站。

7、确保从 to 的转换不会显示 404 页面

404页面的突然增加可能会让你的网站无法操作,尤其是有页面链接的时候。

另外,由于显示的404页面过多,谷歌没有找到应该抓取的页面,会造成抓取预算的浪费。

Google 负责人 John Mueller 指出,抓取预算并不重要,除非是针对大型 网站。

John Mueller 在 Twitter 上表示,他认为爬行预算优化被高估了。对于大多数网站,它没有任何作用,只能帮助大规模的网站。

“IMO 的抓取预算被高估了。实际上,大多数网站 不需要担心。如果您正在抓取网页或运行具有数十亿个 URL 的 网站,这非常重要,但是对于普通的网站来说并不是很重要。”

SEO PowerSuite相关负责人Yauhen Khutarniuk的文章文章也对这一点进行了阐述:

”按道理来说,你应该注意抓取预算,因为你希望谷歌在你的网站上发现尽可能多的重要页面。你也希望它在你的网站上快速找到新的内容,您的抓取预算越大(管理越聪明),这将发生得越快。”

优化你的抓取预算非常重要,因为在网站上快速找到新内容是一项重要的任务,你需要在网站上发现尽可能多的优先页面。

8、如何修复可能出现的 404 页面

首先,将 404 从旧 URL 重定向到新的现有 URL。

一个更简单的方法是,如果你有WordPress网站,使用Screaming Frog抓取网站,使用重定向WordPress插件进行301重定向规则批量上传。

9、网址结构不要太复杂

在准备技术 SEO 时,URL 的结构是一个重要的考虑因素。

这些东西你也一定要注意,比如随机生成索引的动态参数、不易理解的URL,以及其他在技术SEO实施中可能会出现问题的因素。

这些都是重要的因素,因为它们可能会导致索引问题,从而损害 网站 的性能。

10、 更人性化的网址

创建 URL 时,您可以考虑相关内容,然后自动创建 URL。然而,这可能并不合理。

原因是自动生成的 URL 可以遵循几种不同的格式,没有一种是非常用户友好的。

”

例如:

(1)/content/date/time/keyword

(2)/Content/Date/Time/Number string

(3)/内容/类别/日期/时间/

(4)/content/category/date/time/parameter/

正确传达 URL 背后的内容是关键。由于可访问性,它在今天变得更加重要。

URL 的可读性越高越好:如果有人在搜索结果中看到您的 URL,他们可能更愿意点击它,因为他们会确切地看到 URL 与他们搜索的内容的相关性。简而言之,URL 需要匹配用户的搜索意图。

许多现有的 网站 使用过时或混乱的 URL 结构,导致用户参与度低。如果您有一个对用户更友好的 URL,您的 网站 可能会有更高的用户参与度。

11、 重复的 URL

在构建任何链接之前需要考虑的一个 SEO 技术问题是:内容重复。

说到内容重复,主要有以下几个原因:

(1)在网站的各个部分显着重复的内容。

(2) 从其他 网站 抓取内容。

(3) 重复的 URL,其中只存在一个内容。

因为当多个网址代表某网络公司舆情监测表中的一个内容时,确实会混淆搜索引擎。搜索引擎很少同时显示相同的内容,重复的 URL 会削弱其搜索能力。

12、避免使用动态参数

尽管动态参数本身不是 SEO 问题,但如果您无法管理它们的创建并使其在使用中保持一致,它们将来可能会成为潜在威胁。

Jes Scholz在搜索引擎杂志文章上发表了一篇文章,内容涉及动态参数和URL处理的基础知识以及它如何影响SEO。

Scholz 解释说,参数用于以下目的:跟踪、重新排序、过滤、识别、分页、搜索、翻译。

当您发现问题是由 URL 的动态参数引起时,通常将其归因于 URL 的基本管理不善。

在跟踪情况下如何做网络营销计划下,创建搜索引擎抓取的链接时可以使用不同的动态参数。在重新排序的情况下,使用这些不同的动态参数对列表和项目组进行重新排序,然后创建可索引的重复页面,然后被搜索引擎抓取。

如果动态参数没有保持在可管理的水平,可能会在不经意间导致过多重复的内容。

如果不仔细管理一部分内容的创建,这些动态URL的创建实际上会随着时间的推移而积累,这会稀释内容的质量,削弱搜索引擎的执行能力。

还会造成关键词“同类相食”,相互影响,在足够大的范围内严重影响你的竞争力。

13、 短网址比长网址好

长期 SEO 实践的结果是,较短的 URL 优于较长的 URL。

Google 的 John Mueller 说:“当我们有两个内容相同的 URL 时,我们需要选择其中一个显示在搜索结果中,我们会选择较短的一个,这就是规范化。当然,长度并不是主要的影响因素。但是如果我们有两个网址,一个很简洁,一个附加参数很长,显示相同的内容时,我们更倾向于选择短的。有很多例子,比如不同的因素在起作用,但在其他相同的条件下——你有一个越来越短的,我们也会选择更短的。”

长春宣传片中也有证据表明,谷歌专门对短网址进行排序,而不是对较长的网址进行排序。

如果您的 网站 收录很长的 URL,您可以将它们优化为更短、更简洁的 URL,以更好地反映 文章 的主题和用户意图。

查看全部

网站内容抓取(如何在web主机上强制重定向的代码添加到另一个

)

正确的方法是:其中一个重定向到另一个而不是两个。如果两个同时加载,那么站点的版本安全就会有问题。如果您在浏览器中输入网站的网址,请分别测试和测试。

如果两个 URL 都加载了,则会显示两个版本的内容,重复的 URL 可能会导致重复的内容。

为确保您不再遇到此问题,您需要根据站点的平台执行以下操作之一:

在HTACCESS中创建完整的重定向模式(在Apache/CPanel服务器上);

使用 WordPress 中的重定向插件强制重定向。

4、如何在Apache/Cpanel服务器的htaccess中创建重定向

您可以在 Apache/CPanel 服务器的 .htaccess 中执行服务器级全局重定向。Inmotionhosting 有一个很好的教程,教你如何在你的虚拟主机上强制重定向。

如果强制所有网络流量使用HTTPS,则需要使用以下代码。

确保将此代码添加到具有类似前缀(RewriteEngine On、RewriteCond 等)的代码之上。

重写引擎开启

RewriteCond %{HTTPS} !on

RewriteCond %{REQUEST_URI} !^/[0-9]+..+.cpaneldcv$

RewriteCond %{REQUEST_URI} !^/.well-known/pki-validation/[A-F0-9]{32}.txt(?: Comodo DCV)?$

重写规则 (.*)} [L,R=301]

如果只想重定向到特定域,则需要在 htaccess 文件中使用以下代码行:

RewriteCond %{REQUEST_URI} !^/[0-9]+..+.cpaneldcv$

RewriteCond %{REQUEST_URI} !^/.well-known/pki-validation/[A-F0-9]{32}.txt(?: Comodo DCV)?$

重写引擎开启

RewriteCond %{HTTP_HOST} ^ [NC]

重写条件 %{SERVER_PORT} 80

重写规则 ^(.*)$ [R=301,L]

注意:如果您不确定对服务器进行正确的更改,请确保您的服务器公司或 IT 人员执行这些维修。

5、如果你运行的是WordPress网站,请使用插件

解决这些重定向问题的简单方法是使用插件,尤其是在运行 WordPress网站 时。

许多插件可以强制重定向,但这里有一些插件可以使这个过程尽可能简单:CM HTTPS Pro、WP Force SSL、Easy HTTPS Redirection。

关于插件的注意事项:如果您使用了过多的插件,请不要添加。

您可能需要调查您的服务器是否可以使用上述类似的重定向规则(例如,如果您使用的是基于 NGINX 的服务器)。

这里需要声明:插件的权重会对网站的速度产生负面影响,所以不要总以为新的插件会对你有帮助。

6、所有网站链接都应该从

即使执行了上述重定向,也应执行此步骤。

如果您使用绝对 URL 而不是相对 URL,则应该这样做。因为前者总是显示你正在使用的超文本传输协议,如果你使用的是后者,那么你就不需要多注意这个了。

为什么在使用绝对 URL 时需要更改实时链接?因为 Google 会抓取所有这些链接,所以这可能会导致重复的内容。

这似乎是在浪费时间,但事实并非如此。您需要确保 Google 最终可以准确捕获您的 网站。

7、确保从 to 的转换不会显示 404 页面

404页面的突然增加可能会让你的网站无法操作,尤其是有页面链接的时候。

另外,由于显示的404页面过多,谷歌没有找到应该抓取的页面,会造成抓取预算的浪费。

Google 负责人 John Mueller 指出,抓取预算并不重要,除非是针对大型 网站。

John Mueller 在 Twitter 上表示,他认为爬行预算优化被高估了。对于大多数网站,它没有任何作用,只能帮助大规模的网站。

“IMO 的抓取预算被高估了。实际上,大多数网站 不需要担心。如果您正在抓取网页或运行具有数十亿个 URL 的 网站,这非常重要,但是对于普通的网站来说并不是很重要。”

SEO PowerSuite相关负责人Yauhen Khutarniuk的文章文章也对这一点进行了阐述:

”按道理来说,你应该注意抓取预算,因为你希望谷歌在你的网站上发现尽可能多的重要页面。你也希望它在你的网站上快速找到新的内容,您的抓取预算越大(管理越聪明),这将发生得越快。”

优化你的抓取预算非常重要,因为在网站上快速找到新内容是一项重要的任务,你需要在网站上发现尽可能多的优先页面。

8、如何修复可能出现的 404 页面

首先,将 404 从旧 URL 重定向到新的现有 URL。

一个更简单的方法是,如果你有WordPress网站,使用Screaming Frog抓取网站,使用重定向WordPress插件进行301重定向规则批量上传。

9、网址结构不要太复杂

在准备技术 SEO 时,URL 的结构是一个重要的考虑因素。

这些东西你也一定要注意,比如随机生成索引的动态参数、不易理解的URL,以及其他在技术SEO实施中可能会出现问题的因素。

这些都是重要的因素,因为它们可能会导致索引问题,从而损害 网站 的性能。

10、 更人性化的网址

创建 URL 时,您可以考虑相关内容,然后自动创建 URL。然而,这可能并不合理。

原因是自动生成的 URL 可以遵循几种不同的格式,没有一种是非常用户友好的。

”

例如:

(1)/content/date/time/keyword

(2)/Content/Date/Time/Number string

(3)/内容/类别/日期/时间/

(4)/content/category/date/time/parameter/

正确传达 URL 背后的内容是关键。由于可访问性,它在今天变得更加重要。

URL 的可读性越高越好:如果有人在搜索结果中看到您的 URL,他们可能更愿意点击它,因为他们会确切地看到 URL 与他们搜索的内容的相关性。简而言之,URL 需要匹配用户的搜索意图。

许多现有的 网站 使用过时或混乱的 URL 结构,导致用户参与度低。如果您有一个对用户更友好的 URL,您的 网站 可能会有更高的用户参与度。

11、 重复的 URL

在构建任何链接之前需要考虑的一个 SEO 技术问题是:内容重复。

说到内容重复,主要有以下几个原因:

(1)在网站的各个部分显着重复的内容。

(2) 从其他 网站 抓取内容。

(3) 重复的 URL,其中只存在一个内容。

因为当多个网址代表某网络公司舆情监测表中的一个内容时,确实会混淆搜索引擎。搜索引擎很少同时显示相同的内容,重复的 URL 会削弱其搜索能力。

12、避免使用动态参数

尽管动态参数本身不是 SEO 问题,但如果您无法管理它们的创建并使其在使用中保持一致,它们将来可能会成为潜在威胁。

Jes Scholz在搜索引擎杂志文章上发表了一篇文章,内容涉及动态参数和URL处理的基础知识以及它如何影响SEO。

Scholz 解释说,参数用于以下目的:跟踪、重新排序、过滤、识别、分页、搜索、翻译。

当您发现问题是由 URL 的动态参数引起时,通常将其归因于 URL 的基本管理不善。

在跟踪情况下如何做网络营销计划下,创建搜索引擎抓取的链接时可以使用不同的动态参数。在重新排序的情况下,使用这些不同的动态参数对列表和项目组进行重新排序,然后创建可索引的重复页面,然后被搜索引擎抓取。

如果动态参数没有保持在可管理的水平,可能会在不经意间导致过多重复的内容。

如果不仔细管理一部分内容的创建,这些动态URL的创建实际上会随着时间的推移而积累,这会稀释内容的质量,削弱搜索引擎的执行能力。

还会造成关键词“同类相食”,相互影响,在足够大的范围内严重影响你的竞争力。

13、 短网址比长网址好

长期 SEO 实践的结果是,较短的 URL 优于较长的 URL。

Google 的 John Mueller 说:“当我们有两个内容相同的 URL 时,我们需要选择其中一个显示在搜索结果中,我们会选择较短的一个,这就是规范化。当然,长度并不是主要的影响因素。但是如果我们有两个网址,一个很简洁,一个附加参数很长,显示相同的内容时,我们更倾向于选择短的。有很多例子,比如不同的因素在起作用,但在其他相同的条件下——你有一个越来越短的,我们也会选择更短的。”

长春宣传片中也有证据表明,谷歌专门对短网址进行排序,而不是对较长的网址进行排序。

如果您的 网站 收录很长的 URL,您可以将它们优化为更短、更简洁的 URL,以更好地反映 文章 的主题和用户意图。

网站内容抓取( PHP中的有个函数叫file_get_contents_)

网站优化 • 优采云 发表了文章 • 0 个评论 • 75 次浏览 • 2021-10-05 12:03

PHP中的有个函数叫file_get_contents_)

网站优化,除了一些正常的优化方法,我们也比较关注网站的收录,但是收录的前提是让搜索引擎蜘蛛抓取你的网站,那蜘蛛是怎么爬的呢?

如果你真的想知道一些关于这个的东西,你必须了解这个程序。作为一名合格的SEO,编程是你的必修课。即便是说到程序,数据库和编程语言也缺一不可。例如,在 PHP 中有一个名为 file_get_contents 的函数。该函数的作用是获取URL里面的内容,并以文本形式返回结果。当然你也可以使用 URL。

然后,我们可以在程序中使用正则表达式对A-link数据进行提取、合并、减权等杂乱操作,并将数据存入数据库。数据库中有很多数据库,如索引数据库、访问数据库等。为什么索引和条目数不一致?因为它绝对不在同一个库中。

数据抓取完成后,自然会获取数据库中不存在的链接,然后程序会发出另一条指令获取这些库中没有存储的URL。它将一直爬到页面的末尾。当然,你抓得越多,你就越有可能没有抓住它。

百度站长频道会有抓取频率和抓取时间数据。你应该看到每只蜘蛛爬行都是不规则的,但是通过日常观察,你会发现页面越深,被抓到的概率越低。原因很简单。蜘蛛并不总是爬到你的 网站 上的所有 网站,而是有一个空间并随机爬行。 查看全部

网站内容抓取(

PHP中的有个函数叫file_get_contents_)

网站优化,除了一些正常的优化方法,我们也比较关注网站的收录,但是收录的前提是让搜索引擎蜘蛛抓取你的网站,那蜘蛛是怎么爬的呢?

如果你真的想知道一些关于这个的东西,你必须了解这个程序。作为一名合格的SEO,编程是你的必修课。即便是说到程序,数据库和编程语言也缺一不可。例如,在 PHP 中有一个名为 file_get_contents 的函数。该函数的作用是获取URL里面的内容,并以文本形式返回结果。当然你也可以使用 URL。

然后,我们可以在程序中使用正则表达式对A-link数据进行提取、合并、减权等杂乱操作,并将数据存入数据库。数据库中有很多数据库,如索引数据库、访问数据库等。为什么索引和条目数不一致?因为它绝对不在同一个库中。

数据抓取完成后,自然会获取数据库中不存在的链接,然后程序会发出另一条指令获取这些库中没有存储的URL。它将一直爬到页面的末尾。当然,你抓得越多,你就越有可能没有抓住它。

百度站长频道会有抓取频率和抓取时间数据。你应该看到每只蜘蛛爬行都是不规则的,但是通过日常观察,你会发现页面越深,被抓到的概率越低。原因很简单。蜘蛛并不总是爬到你的 网站 上的所有 网站,而是有一个空间并随机爬行。

网站内容抓取( PHP中有个函数叫file_get_contents的优化方法)

网站优化 • 优采云 发表了文章 • 0 个评论 • 63 次浏览 • 2021-10-05 11:30

PHP中有个函数叫file_get_contents的优化方法)

网站优化,除了一些正常的优化方法,我们也比较关注网站的收录,但是收录的前提是让搜索引擎蜘蛛抓取你的网站,那蜘蛛是怎么爬的呢?

如果你真的想知道一些关于这个的东西,你必须了解这个程序。作为一名合格的SEO,编程是你的必修课。即便是说到程序,数据库和编程语言也缺一不可。例如,在 PHP 中有一个名为 file_get_contents 的函数。该函数的作用是获取URL里面的内容,并以文本形式返回结果。当然你也可以使用 URL。

然后,我们可以在程序中使用正则表达式对A-link数据进行提取、合并、减权等杂乱操作,并将数据存入数据库。数据库中有很多数据库,如索引数据库、访问数据库等。为什么索引和条目数不一致?因为它绝对不在同一个库中。

数据抓取完成后,自然会获取数据库中不存在的链接,然后程序会发出另一条指令获取这些库中没有存储的URL。它将一直爬到页面的末尾。当然,你抓得越多,你就越有可能没有抓住它。

百度站长频道会有抓取频率和抓取时间数据。你应该看到每只蜘蛛爬行都是不规则的,但是通过日常观察,你会发现页面越深,被抓到的概率越低。原因很简单。蜘蛛并不总是爬到你的 网站 上的所有 网站,而是有一个空间并随机爬行。

标签:如何抓取蜘蛛引擎的内容

转载:感谢您对Yudi Silent个人博客网站的认可,以及网站分享的经验、工具和文章。欢迎各位朋友分享到个人站长或朋友圈,转载请注明出处文章。

() 查看全部

网站内容抓取(

PHP中有个函数叫file_get_contents的优化方法)

网站优化,除了一些正常的优化方法,我们也比较关注网站的收录,但是收录的前提是让搜索引擎蜘蛛抓取你的网站,那蜘蛛是怎么爬的呢?

如果你真的想知道一些关于这个的东西,你必须了解这个程序。作为一名合格的SEO,编程是你的必修课。即便是说到程序,数据库和编程语言也缺一不可。例如,在 PHP 中有一个名为 file_get_contents 的函数。该函数的作用是获取URL里面的内容,并以文本形式返回结果。当然你也可以使用 URL。

然后,我们可以在程序中使用正则表达式对A-link数据进行提取、合并、减权等杂乱操作,并将数据存入数据库。数据库中有很多数据库,如索引数据库、访问数据库等。为什么索引和条目数不一致?因为它绝对不在同一个库中。

数据抓取完成后,自然会获取数据库中不存在的链接,然后程序会发出另一条指令获取这些库中没有存储的URL。它将一直爬到页面的末尾。当然,你抓得越多,你就越有可能没有抓住它。

百度站长频道会有抓取频率和抓取时间数据。你应该看到每只蜘蛛爬行都是不规则的,但是通过日常观察,你会发现页面越深,被抓到的概率越低。原因很简单。蜘蛛并不总是爬到你的 网站 上的所有 网站,而是有一个空间并随机爬行。

标签:如何抓取蜘蛛引擎的内容

转载:感谢您对Yudi Silent个人博客网站的认可,以及网站分享的经验、工具和文章。欢迎各位朋友分享到个人站长或朋友圈,转载请注明出处文章。

()

网站内容抓取( 网站页面不是让搜索引擎抓的越多越好吗,怎么让网站内容不被抓取)

网站优化 • 优采云 发表了文章 • 0 个评论 • 75 次浏览 • 2021-10-05 11:28

网站页面不是让搜索引擎抓的越多越好吗,怎么让网站内容不被抓取)

有朋友可能会疑惑,网站的页面不就是让搜索引擎尽量抓取吗?怎么能有防止网站的内容被爬取的想法。

首先,一个网站可以分配的权重是有限的,即使是Pr10站,也不可能无限分配权重。此权重包括指向其他人 网站 的链接和自己的 网站 内部链接。

锁链之外,除非是想被锁链的人。否则,所有的外部链接都需要被搜索引擎抓取。这超出了本文的范围。

内链,因为一些网站有很多重复或者冗余的内容。例如,一些基于条件的搜索结果。特别是对于一些B2C站,您可以在特殊查询页面或在所有产品页面的某个位置按产品类型、型号、颜色、尺寸等进行搜索。虽然这些页面对于浏览者来说极其方便,但是对于搜索引擎来说,它们会消耗大量的蜘蛛爬行时间,尤其是在网站页面很多的情况下。同时,页面权重也会分散。

另外,网站管理着登录页、备份页、测试页等,站长不想让搜索引擎收录。

因此,有必要防止网页的某些内容,或某些页面被搜索引擎搜索收录。

笔者首先介绍几种比较有效的方法:

1.在FLASH中展示你不想成为的内容收录

众所周知,搜索引擎对FLASH中内容的抓取能力有限,无法完全抓取FLASH中的所有内容。不幸的是,不能保证 FLASH 的所有内容都不会被抓取。因为谷歌和 Adobe 正在努力实现 FLASH 捕获技术。

2.使用robos文件

这是目前最有效的方法,但它有一个很大的缺点。只是不要发送任何内容或链接。众所周知,在SEO方面,更健康的页面应该进进出出。有外链链接,页面也需要有外链网站,所以robots文件控件让这个页面只能访问,搜索引擎不知道内容是什么。此页面将被归类为低质量页面。重量可能会受到惩罚。这个主要用于网站管理页面、测试页面等。

3.使用nofollow标签来包装你不想成为的内容收录

这种方法并不能完全保证它不会是收录,因为这不是一个严格要求遵守的标签。另外,如果有外部网站链接到带有nofollow标签的页面。这很可能会被搜索引擎抓取。

4. 使用Meta Noindex标签添加关注标签

这种方法既可以防止收录,也可以传递权重。要不要通过,就看网站工地主的需要了。这种方法的缺点是也会大大浪费蜘蛛爬行的时间。

5.使用robots文件在页面上使用iframe标签显示需要搜索引擎的内容收录。robots文件可以防止iframe标签外的内容被收录。因此,您可以将您不想要的内容 收录 放在普通页面标签下。想要成为收录的内容放在iframe标签中。

然后,让我谈谈失败的方法。您将来不应使用这些方法。

1.使用表单

谷歌和百度已经能够抓取表单内容,无法阻止收录。

2.使用Javascript和Ajax技术

以目前的技术,Ajax和javascript的最终计算结果还是以HTML的形式传输到浏览器中进行显示,所以这也无法阻止收录。 查看全部

网站内容抓取(

网站页面不是让搜索引擎抓的越多越好吗,怎么让网站内容不被抓取)

有朋友可能会疑惑,网站的页面不就是让搜索引擎尽量抓取吗?怎么能有防止网站的内容被爬取的想法。

首先,一个网站可以分配的权重是有限的,即使是Pr10站,也不可能无限分配权重。此权重包括指向其他人 网站 的链接和自己的 网站 内部链接。

锁链之外,除非是想被锁链的人。否则,所有的外部链接都需要被搜索引擎抓取。这超出了本文的范围。

内链,因为一些网站有很多重复或者冗余的内容。例如,一些基于条件的搜索结果。特别是对于一些B2C站,您可以在特殊查询页面或在所有产品页面的某个位置按产品类型、型号、颜色、尺寸等进行搜索。虽然这些页面对于浏览者来说极其方便,但是对于搜索引擎来说,它们会消耗大量的蜘蛛爬行时间,尤其是在网站页面很多的情况下。同时,页面权重也会分散。

另外,网站管理着登录页、备份页、测试页等,站长不想让搜索引擎收录。

因此,有必要防止网页的某些内容,或某些页面被搜索引擎搜索收录。

笔者首先介绍几种比较有效的方法:

1.在FLASH中展示你不想成为的内容收录

众所周知,搜索引擎对FLASH中内容的抓取能力有限,无法完全抓取FLASH中的所有内容。不幸的是,不能保证 FLASH 的所有内容都不会被抓取。因为谷歌和 Adobe 正在努力实现 FLASH 捕获技术。

2.使用robos文件

这是目前最有效的方法,但它有一个很大的缺点。只是不要发送任何内容或链接。众所周知,在SEO方面,更健康的页面应该进进出出。有外链链接,页面也需要有外链网站,所以robots文件控件让这个页面只能访问,搜索引擎不知道内容是什么。此页面将被归类为低质量页面。重量可能会受到惩罚。这个主要用于网站管理页面、测试页面等。

3.使用nofollow标签来包装你不想成为的内容收录

这种方法并不能完全保证它不会是收录,因为这不是一个严格要求遵守的标签。另外,如果有外部网站链接到带有nofollow标签的页面。这很可能会被搜索引擎抓取。

4. 使用Meta Noindex标签添加关注标签

这种方法既可以防止收录,也可以传递权重。要不要通过,就看网站工地主的需要了。这种方法的缺点是也会大大浪费蜘蛛爬行的时间。

5.使用robots文件在页面上使用iframe标签显示需要搜索引擎的内容收录。robots文件可以防止iframe标签外的内容被收录。因此,您可以将您不想要的内容 收录 放在普通页面标签下。想要成为收录的内容放在iframe标签中。

然后,让我谈谈失败的方法。您将来不应使用这些方法。

1.使用表单

谷歌和百度已经能够抓取表单内容,无法阻止收录。

2.使用Javascript和Ajax技术

以目前的技术,Ajax和javascript的最终计算结果还是以HTML的形式传输到浏览器中进行显示,所以这也无法阻止收录。

网站内容抓取(Excel教程Excel函数Excel表格制作Excel2010Excel实用技巧Excel视频教程)

网站优化 • 优采云 发表了文章 • 0 个评论 • 72 次浏览 • 2021-10-11 22:16

我对网页内容的爬取比较感兴趣,所以就简单的学习了一下。如果我不使用任何框架来抓取网页内容,感觉有点困难。我会继续前进。这里使用的jsoup框架,爬取网页的内容和使用jquery选择网页的内容类似,上手很快。下面就来简单介绍一下吧!

首先是获取网络资源的方法:

/**

* 获取网络中的超链接

*

* @param urlStr

* 传入网络地址

* @return 返回网页中的所有的超链接信息

*/

public String getInternet(String urlStr, String encoding) {

URL url = null;

URLConnection conn = null;

String nextLine = null;

StringBuffer sb = new StringBuffer();

// 设置系统的代理信息

Properties props = System.getProperties();

props.put("proxySet", "true");

props.put("proxyHost", "10.27.16.212");

props.put("proxyPort", "3128");

System.setProperties(props);

try {

// 获取网络资源

url = new URL(urlStr);

// 获取资源连接

conn = url.openConnection();

conn.setReadTimeout(30000);//设置30秒后超时

conn.connect();

BufferedReader reader = new BufferedReader(new InputStreamReader(

conn.getInputStream(), encoding));

// 开始读取网页信息获取网页中的超链接信息

while ((nextLine = reader.readLine()) != null) {

sb.append(nextLine);

}

} catch (Exception e) {

e.printStackTrace();

}

return sb.toString();

}

获取到网络资源后,我们可以根据自己的需要筛选出对自己有用的资源,下面开始抢资源:

public static void main(String[] args) {

MavenTest test = new MavenTest();

try {

String html = test.getInternet( "http://www.weather.com.cn/html ... ot%3B,"UTF-8");

//将html文档转换为Document文档

Document doc = Jsoup.parse(html);

//获取class为.weatherYubaoBox的div的元素

Elements tableElements = doc.select("div.weatherYubaoBox");

// System.out.println(tableElements.html());

//获取所有的th元素

Elements thElements = tableElements.select("th");

//打印出日期的标题信息

for (int i = 0; i < thElements.size(); i++) {

System.out.print(" "+thElements.get(i).text() + "\t");

}

// 输出标题之后进行换行

System.out.println();

//获取表格的tbody

Elements tbodyElements = tableElements.select("tbody");

for (int j = 1; j < tbodyElements.size(); j++) {

//获取tr中的信息

Elements trElements = tbodyElements.get(j).select("tr");

for (int k = 0; k < trElements.size(); k++) {

//获取单元格中的信息

Elements tdElements = trElements.get(k).select("td");

//根据元素的多少判断出白天和夜晚的

if (tdElements.size() > 6) {

for (int m = 0; m < tdElements.size(); m++) {

System.out.print(tdElements.get(m).text() + "\t");

}

// 白天的数据打印完成后进行换行

System.out.println();

}else{

for(int n =0; n < tdElements.size(); n++){

System.out.print("\t"+tdElements.get(n).text());

}

//打印完成夜间的天气信息进行换行处理

System.out.println();

}

}

}

} catch (Exception e) {

e.printStackTrace();

}

}

操作结果如下:

最后,附上框架的地址: 查看全部

网站内容抓取(Excel教程Excel函数Excel表格制作Excel2010Excel实用技巧Excel视频教程)

我对网页内容的爬取比较感兴趣,所以就简单的学习了一下。如果我不使用任何框架来抓取网页内容,感觉有点困难。我会继续前进。这里使用的jsoup框架,爬取网页的内容和使用jquery选择网页的内容类似,上手很快。下面就来简单介绍一下吧!

首先是获取网络资源的方法:

/**

* 获取网络中的超链接

*

* @param urlStr

* 传入网络地址

* @return 返回网页中的所有的超链接信息

*/

public String getInternet(String urlStr, String encoding) {

URL url = null;

URLConnection conn = null;

String nextLine = null;

StringBuffer sb = new StringBuffer();

// 设置系统的代理信息

Properties props = System.getProperties();

props.put("proxySet", "true");

props.put("proxyHost", "10.27.16.212");

props.put("proxyPort", "3128");

System.setProperties(props);

try {

// 获取网络资源

url = new URL(urlStr);

// 获取资源连接

conn = url.openConnection();

conn.setReadTimeout(30000);//设置30秒后超时

conn.connect();

BufferedReader reader = new BufferedReader(new InputStreamReader(

conn.getInputStream(), encoding));

// 开始读取网页信息获取网页中的超链接信息

while ((nextLine = reader.readLine()) != null) {

sb.append(nextLine);

}

} catch (Exception e) {

e.printStackTrace();

}

return sb.toString();

}

获取到网络资源后,我们可以根据自己的需要筛选出对自己有用的资源,下面开始抢资源:

public static void main(String[] args) {

MavenTest test = new MavenTest();

try {

String html = test.getInternet( "http://www.weather.com.cn/html ... ot%3B,"UTF-8");

//将html文档转换为Document文档

Document doc = Jsoup.parse(html);

//获取class为.weatherYubaoBox的div的元素

Elements tableElements = doc.select("div.weatherYubaoBox");

// System.out.println(tableElements.html());

//获取所有的th元素

Elements thElements = tableElements.select("th");

//打印出日期的标题信息

for (int i = 0; i < thElements.size(); i++) {

System.out.print(" "+thElements.get(i).text() + "\t");

}

// 输出标题之后进行换行

System.out.println();

//获取表格的tbody

Elements tbodyElements = tableElements.select("tbody");

for (int j = 1; j < tbodyElements.size(); j++) {

//获取tr中的信息

Elements trElements = tbodyElements.get(j).select("tr");

for (int k = 0; k < trElements.size(); k++) {

//获取单元格中的信息

Elements tdElements = trElements.get(k).select("td");

//根据元素的多少判断出白天和夜晚的

if (tdElements.size() > 6) {

for (int m = 0; m < tdElements.size(); m++) {

System.out.print(tdElements.get(m).text() + "\t");

}

// 白天的数据打印完成后进行换行

System.out.println();

}else{

for(int n =0; n < tdElements.size(); n++){

System.out.print("\t"+tdElements.get(n).text());

}

//打印完成夜间的天气信息进行换行处理

System.out.println();

}

}

}

} catch (Exception e) {

e.printStackTrace();

}

}

操作结果如下:

最后,附上框架的地址:

网站内容抓取(横琴建站:中小企业在做网站建设时需要注意哪些问题?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 59 次浏览 • 2021-10-11 01:40

导读:随着企业的快速发展壮大,越来越多的中小企业重视品牌网站建设和营销网站建设,想利用互联网提升品牌知名度并获得更多潜在的合作机会和更精准的客户。但是,企业网站的建设与普通的网站不同。这就需要深入的行业研究,挖掘出公司各方面的优势,塑造独特的企业形象,尤其是很多细节,直接影响到公司。网站@的作用和目的>,应该注意哪些问题中小企业在做网站建设时注意什么?下面横琴建个网站跟大家分享一下SEO的相关知识。

部分内容质量较高的网页用户可以正常访问,但百度Pider无法正常访问和抓取,导致搜索结果覆盖不足,给百度搜索引擎和网站造成损失。百度称这种情况为“抢占异常”。百度搜索引擎会认为内容量大的网站存在无法正常抓取的用户体验缺陷,降低对网站的评价。在抓取、索引和排序方面,百度搜索引擎将受到影响。这会影响网站从百度获得的流量。

下面介绍一些常见的站长爬虫异常的原因:

服务器连接异常有两种情况:一种是网站不稳定,百度PIDer尝试连接时暂时无法连接到你的网站服务器;另一种是百度PIDer一直无法连接到你的网站服务器。

服务器连接异常的原因通常是你的网站服务器太大,过载。您的 网站 也可能运行异常。请检查网站的web服务器(如apache、iis)是否安装运行正常,并使用浏览器查看主页是否可以正常访问。您的 网站 和主机也可能会阻止百度蜘蛛的访问。您需要检查网站的防火墙和主机。

网络运营商的例外:网络运营商分为电信和联通两种。百度Pider无法通过电信或网通访问您的网站。如果出现这种情况,您需要联系网络服务商,或者购买空间和二线服务或CDN服务。

DNS异常:当百度蜘蛛无法解析您的网站 IP地址时,会发生DNS异常。可能是你的网站 IP地址错误,或者域名服务商已经屏蔽了百度蜘蛛。请使用 whois 或 host 来检查您的 网站 IP 地址是否正确且可解析。如果没有,请联系域名注册商更新您的 IP 地址。

IP阻塞:IP阻塞是限制网络的导出IP地址,禁止该IP段的用户访问内容。这里特指对百度Piderip的屏蔽。仅当您的 网站 不希望百度 Pider 访问时才需要此设置。如果您希望百度Pider访问您的网站,请检查相关设置中是否错误添加了百度Pider IP。你的网站所在的空间服务商也可能封禁百度IP。这时候需要联系服务商更改设置。

UA 阻塞:UA 是用户代理服务器通过 UA 识别的访问者的身份。当一个网站访问指定的UA返回异常页面(如403500)或跳转到另一个页面时,称为UA阻塞。这个设置只在你不想要baidupider的时候使用访问你的网站只需要,如果你想让百度皮德访问你的网站,在用户代理相关设置中是否有百度皮德如,并及时修改。

死链接:页面无效,不能为用户提供任何有价值信息的页面为死链接,包括协议死链接和内容死链接

协议死链接:页面的TCP协议状态/HTTP协议状态明确显示死链接,如404、403、503状态等。

内容死链接:服务器返回的状态正常,但内容已更改为不存在、已删除或需要权限的页面,与原内容无关。

对于死链接,我们建议网站使用协议死链接,通过百度站长平台的死链接工具提交给百度,这样百度可以更快的找到死链接,减少死链接对用户和搜索的负面影响引擎。

异常跳转:跳转就是将网络请求重定向到另一个位置。异常跳转是指以下几种情况:

1)当前页面为无效页面(内容已删除、死链接等),直接跳转到上一目录或首页,百度建议站长删除无效页面的入口超链接

对于长期重定向到其他域名,例如在网站上更改域名,百度建议使用301重定向协议进行设置。

其他例外:

1) 百度推荐人异常:网页返回与百度推荐人正常内容不同的行为。

2) 百度UA异常:返回百度UA的网页行为与页面原创内容不同。

3)JS跳转异常:网页加载了百度无法识别的JS跳转代码,用户通过搜索结果进入网页后跳转。

4) 压力过大导致意外阻塞:百度会根据网站规模、流量等信息自动设置合理的爬取压力。但是,在异常压力控制等异常情况下,服务器会根据自身负载受到保护和意外锁定。在这种情况下,请在返回码中返回503(表示“服务不可用”),以便百度Pider在一段时间内再次尝试获取链接。如果网站处于空闲状态,将成功获取网站。

横琴工地网络营销托管代理运营服务商,专注中小企业网络营销技术服务,为中小企业提供企业网站建设、网络营销托管代理运营、SEM托管代理运营、SEO站群建设、企业网站代理运营、小程序开发推广、广告媒体发布代理运营、美团小红书代理运营、微信公众号代理运营等及中小企业宣传、营销推广、技术开发、精准客户在相关服务方面,我们致力于成为合作企业的网络营销外包托管代理服务商。 查看全部

网站内容抓取(横琴建站:中小企业在做网站建设时需要注意哪些问题?)

导读:随着企业的快速发展壮大,越来越多的中小企业重视品牌网站建设和营销网站建设,想利用互联网提升品牌知名度并获得更多潜在的合作机会和更精准的客户。但是,企业网站的建设与普通的网站不同。这就需要深入的行业研究,挖掘出公司各方面的优势,塑造独特的企业形象,尤其是很多细节,直接影响到公司。网站@的作用和目的>,应该注意哪些问题中小企业在做网站建设时注意什么?下面横琴建个网站跟大家分享一下SEO的相关知识。

部分内容质量较高的网页用户可以正常访问,但百度Pider无法正常访问和抓取,导致搜索结果覆盖不足,给百度搜索引擎和网站造成损失。百度称这种情况为“抢占异常”。百度搜索引擎会认为内容量大的网站存在无法正常抓取的用户体验缺陷,降低对网站的评价。在抓取、索引和排序方面,百度搜索引擎将受到影响。这会影响网站从百度获得的流量。

下面介绍一些常见的站长爬虫异常的原因:

服务器连接异常有两种情况:一种是网站不稳定,百度PIDer尝试连接时暂时无法连接到你的网站服务器;另一种是百度PIDer一直无法连接到你的网站服务器。

服务器连接异常的原因通常是你的网站服务器太大,过载。您的 网站 也可能运行异常。请检查网站的web服务器(如apache、iis)是否安装运行正常,并使用浏览器查看主页是否可以正常访问。您的 网站 和主机也可能会阻止百度蜘蛛的访问。您需要检查网站的防火墙和主机。

网络运营商的例外:网络运营商分为电信和联通两种。百度Pider无法通过电信或网通访问您的网站。如果出现这种情况,您需要联系网络服务商,或者购买空间和二线服务或CDN服务。

DNS异常:当百度蜘蛛无法解析您的网站 IP地址时,会发生DNS异常。可能是你的网站 IP地址错误,或者域名服务商已经屏蔽了百度蜘蛛。请使用 whois 或 host 来检查您的 网站 IP 地址是否正确且可解析。如果没有,请联系域名注册商更新您的 IP 地址。

IP阻塞:IP阻塞是限制网络的导出IP地址,禁止该IP段的用户访问内容。这里特指对百度Piderip的屏蔽。仅当您的 网站 不希望百度 Pider 访问时才需要此设置。如果您希望百度Pider访问您的网站,请检查相关设置中是否错误添加了百度Pider IP。你的网站所在的空间服务商也可能封禁百度IP。这时候需要联系服务商更改设置。

UA 阻塞:UA 是用户代理服务器通过 UA 识别的访问者的身份。当一个网站访问指定的UA返回异常页面(如403500)或跳转到另一个页面时,称为UA阻塞。这个设置只在你不想要baidupider的时候使用访问你的网站只需要,如果你想让百度皮德访问你的网站,在用户代理相关设置中是否有百度皮德如,并及时修改。

死链接:页面无效,不能为用户提供任何有价值信息的页面为死链接,包括协议死链接和内容死链接

协议死链接:页面的TCP协议状态/HTTP协议状态明确显示死链接,如404、403、503状态等。

内容死链接:服务器返回的状态正常,但内容已更改为不存在、已删除或需要权限的页面,与原内容无关。

对于死链接,我们建议网站使用协议死链接,通过百度站长平台的死链接工具提交给百度,这样百度可以更快的找到死链接,减少死链接对用户和搜索的负面影响引擎。

异常跳转:跳转就是将网络请求重定向到另一个位置。异常跳转是指以下几种情况:

1)当前页面为无效页面(内容已删除、死链接等),直接跳转到上一目录或首页,百度建议站长删除无效页面的入口超链接

对于长期重定向到其他域名,例如在网站上更改域名,百度建议使用301重定向协议进行设置。

其他例外:

1) 百度推荐人异常:网页返回与百度推荐人正常内容不同的行为。

2) 百度UA异常:返回百度UA的网页行为与页面原创内容不同。

3)JS跳转异常:网页加载了百度无法识别的JS跳转代码,用户通过搜索结果进入网页后跳转。

4) 压力过大导致意外阻塞:百度会根据网站规模、流量等信息自动设置合理的爬取压力。但是,在异常压力控制等异常情况下,服务器会根据自身负载受到保护和意外锁定。在这种情况下,请在返回码中返回503(表示“服务不可用”),以便百度Pider在一段时间内再次尝试获取链接。如果网站处于空闲状态,将成功获取网站。

横琴工地网络营销托管代理运营服务商,专注中小企业网络营销技术服务,为中小企业提供企业网站建设、网络营销托管代理运营、SEM托管代理运营、SEO站群建设、企业网站代理运营、小程序开发推广、广告媒体发布代理运营、美团小红书代理运营、微信公众号代理运营等及中小企业宣传、营销推广、技术开发、精准客户在相关服务方面,我们致力于成为合作企业的网络营销外包托管代理服务商。

网站内容抓取(做SEO优化的目地就是通过外链与内链两种操作方式)

网站优化 • 优采云 发表了文章 • 0 个评论 • 66 次浏览 • 2021-10-10 22:24

我们知道SEO优化的目的是选择关键词,通过外链、内链等方式,让搜索引擎准确快速的捕捉到目标网站的信息。在搜索信息的排名中处于极佳的位置,从而提升网站的推广效果。从专业的角度来看,要达到这个目标,必须做到以下三点:

1、原创文章内容

无论是网站首页的文章还是内页的文章,SEO优化的第一步都可以通过把握< @原创。所谓原创是网站自己写的,其内容可以是已经发生或正在发生的事件、人物、新知识、新体验等,但是在写的时候一定要原创,即网站就是这个文章的来源。现在搜索引擎更加重视原创文章。

2、做好内外部链接

网站首页权重比较高,越往内页,搜索引擎给的权重越低。我该怎么办? SEO优化导致两种操作模式:外链和内链。外链是增加友情链接网站,通过友情引流网站,带动这个网站的流量。内链是通过设置在内页文章的关键词和主关键词之间建立内连接,这样搜索引擎就会受到链接数的影响到内部页面关键词。先取。

3、注意单页链接

网站 当有特价促销,或者新品出现时,可以结合活动的促销做一些单页链接的SEO优化。通过这个推广效果明显的单页内链带动网站的流量,通过单页的推广带动整个网站有效的客户增长和销售增长也是不可忽视的活动。 查看全部

网站内容抓取(做SEO优化的目地就是通过外链与内链两种操作方式)

我们知道SEO优化的目的是选择关键词,通过外链、内链等方式,让搜索引擎准确快速的捕捉到目标网站的信息。在搜索信息的排名中处于极佳的位置,从而提升网站的推广效果。从专业的角度来看,要达到这个目标,必须做到以下三点:

1、原创文章内容

无论是网站首页的文章还是内页的文章,SEO优化的第一步都可以通过把握< @原创。所谓原创是网站自己写的,其内容可以是已经发生或正在发生的事件、人物、新知识、新体验等,但是在写的时候一定要原创,即网站就是这个文章的来源。现在搜索引擎更加重视原创文章。

2、做好内外部链接

网站首页权重比较高,越往内页,搜索引擎给的权重越低。我该怎么办? SEO优化导致两种操作模式:外链和内链。外链是增加友情链接网站,通过友情引流网站,带动这个网站的流量。内链是通过设置在内页文章的关键词和主关键词之间建立内连接,这样搜索引擎就会受到链接数的影响到内部页面关键词。先取。

3、注意单页链接

网站 当有特价促销,或者新品出现时,可以结合活动的促销做一些单页链接的SEO优化。通过这个推广效果明显的单页内链带动网站的流量,通过单页的推广带动整个网站有效的客户增长和销售增长也是不可忽视的活动。

网站内容抓取(超级排名系统原文链接:吸引百度蜘蛛抓取网站的基本条件)

网站优化 • 优采云 发表了文章 • 0 个评论 • 97 次浏览 • 2021-10-10 12:20

原文出处:超级排位系统

原文链接:吸引百度蜘蛛爬取的基本条件网站-超级排名系统

为了创建一个新的网站,我们首先考虑如何将蜘蛛吸引到我们的网站,采集我们的文章并建立一个排名。如果网站的管理员不知道怎么吸引蜘蛛,你连上手的资格都没有,那网站怎么会很快被蜘蛛抓到呢?超级排名系统的编辑会组织发布。

在互联网时代,我们想要的大部分信息都是通过“互联网搜索”获得的。比如很多人在购买某种产品之前都会上网查看相关信息,看看品牌的口碑和评价。调查显示,87%的网民会通过搜索引擎服务找到自己需要的信息,近70%的网民会直接在搜索结果自然排名的首页找到自己需要的信息。

由此可见SEO优化是非常有必要的,不仅可以提高曝光率,还可以增加销量。下面百度搜索引擎优化告诉你如何让网站快速抓取。

关键词的具体作用是在搜索引擎中排名,让用户尽快找到我的网站。所以关键词是搜索引擎优化的核心。

外链是SEO优化过程中的一个环节,间接影响着网站的权重。常见的链接有:锚文本链接、纯文本链接和图片链接。

网络爬虫是一种自动提取网页的程序,是搜索引擎的重要组成部分。例如,百度的蜘蛛爬网时需要定义网页并过滤和分析网页数据。

对于页面,爬取是收录的前提。只有爬得更多,我们才能收录更多。如果网站页面更新频繁,爬虫程序会频繁访问该页面。优质内容,尤其是原创内容,是爬虫喜欢捕捉的目标。

权威高配老网站享受VIP级待遇。这种网站的爬取频率高,爬取的页面数量大,爬取深度高,页面数量也比较多。这就是区别。

网站服务器是访问网站的基石。如果长时间打不开,就会长时间敲门。如果长时间没有回音,游客就会因为进不去,一个接着一个离开。蜘蛛来访也是访客之一。如果服务器不稳定,蜘蛛每次进入页面爬行都会被屏蔽,蜘蛛对网站的印象会越来越差,导致分数越来越低,自然排名也越来越低。

网站内容更新频繁,会吸引蜘蛛更频繁的访问。如果文章定期更新,蜘蛛会定期访问。蜘蛛每次爬取时,将页面数据存入数据库,分析后采集页面。如果蜘蛛每次爬行,发现收录的内容完全一样,蜘蛛就会判断网站,从而减少对网站的爬行。

蜘蛛的根本目的是发现有价值的“新”事物,所以原创优质内容对蜘蛛的吸引力是巨大的。如果能得到一只蜘蛛一样的,自然应该给网站打上“优秀”的标签,经常爬取网站。

抓蜘蛛是有规则的。如果它太深而无法隐藏,蜘蛛会找到自己的路。爬取过程很简单,所以网站结构应该不会太复杂。

在网站的构建中,程序可以生成大量的页面,通常是通过参数来实现的。一定要保证一个页面对应一个URL,否则会造成大量的重复内容,影响蜘蛛的抓取。如果一个页面对应的URL很多,可以尝试通过301重定向、canonical标签或者robots来处理,保证爬虫只抓取一个标准的URL。

对于新站来说,在网站建设初期,相对流量小,蜘蛛少。外链可以增加网页的曝光率和蜘蛛爬行,但需要注意外链的质量。 查看全部

网站内容抓取(超级排名系统原文链接:吸引百度蜘蛛抓取网站的基本条件)

原文出处:超级排位系统

原文链接:吸引百度蜘蛛爬取的基本条件网站-超级排名系统

为了创建一个新的网站,我们首先考虑如何将蜘蛛吸引到我们的网站,采集我们的文章并建立一个排名。如果网站的管理员不知道怎么吸引蜘蛛,你连上手的资格都没有,那网站怎么会很快被蜘蛛抓到呢?超级排名系统的编辑会组织发布。

在互联网时代,我们想要的大部分信息都是通过“互联网搜索”获得的。比如很多人在购买某种产品之前都会上网查看相关信息,看看品牌的口碑和评价。调查显示,87%的网民会通过搜索引擎服务找到自己需要的信息,近70%的网民会直接在搜索结果自然排名的首页找到自己需要的信息。

由此可见SEO优化是非常有必要的,不仅可以提高曝光率,还可以增加销量。下面百度搜索引擎优化告诉你如何让网站快速抓取。

关键词的具体作用是在搜索引擎中排名,让用户尽快找到我的网站。所以关键词是搜索引擎优化的核心。

外链是SEO优化过程中的一个环节,间接影响着网站的权重。常见的链接有:锚文本链接、纯文本链接和图片链接。

网络爬虫是一种自动提取网页的程序,是搜索引擎的重要组成部分。例如,百度的蜘蛛爬网时需要定义网页并过滤和分析网页数据。

对于页面,爬取是收录的前提。只有爬得更多,我们才能收录更多。如果网站页面更新频繁,爬虫程序会频繁访问该页面。优质内容,尤其是原创内容,是爬虫喜欢捕捉的目标。

权威高配老网站享受VIP级待遇。这种网站的爬取频率高,爬取的页面数量大,爬取深度高,页面数量也比较多。这就是区别。

网站服务器是访问网站的基石。如果长时间打不开,就会长时间敲门。如果长时间没有回音,游客就会因为进不去,一个接着一个离开。蜘蛛来访也是访客之一。如果服务器不稳定,蜘蛛每次进入页面爬行都会被屏蔽,蜘蛛对网站的印象会越来越差,导致分数越来越低,自然排名也越来越低。

网站内容更新频繁,会吸引蜘蛛更频繁的访问。如果文章定期更新,蜘蛛会定期访问。蜘蛛每次爬取时,将页面数据存入数据库,分析后采集页面。如果蜘蛛每次爬行,发现收录的内容完全一样,蜘蛛就会判断网站,从而减少对网站的爬行。

蜘蛛的根本目的是发现有价值的“新”事物,所以原创优质内容对蜘蛛的吸引力是巨大的。如果能得到一只蜘蛛一样的,自然应该给网站打上“优秀”的标签,经常爬取网站。

抓蜘蛛是有规则的。如果它太深而无法隐藏,蜘蛛会找到自己的路。爬取过程很简单,所以网站结构应该不会太复杂。

在网站的构建中,程序可以生成大量的页面,通常是通过参数来实现的。一定要保证一个页面对应一个URL,否则会造成大量的重复内容,影响蜘蛛的抓取。如果一个页面对应的URL很多,可以尝试通过301重定向、canonical标签或者robots来处理,保证爬虫只抓取一个标准的URL。

对于新站来说,在网站建设初期,相对流量小,蜘蛛少。外链可以增加网页的曝光率和蜘蛛爬行,但需要注意外链的质量。

网站内容抓取(如何分析b站同一个视频下面的弹幕和评论(图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 183 次浏览 • 2021-10-10 07:36

因为学期的项目,需要分析b站同一个视频下的弹幕和评论,所以专门研究了一下,抓到了大概100多条视频评论和弹幕。

b站的视频有两个相关的id号,一个是cid,一个是大家都知道的AV号。你需要抓住弹幕的是cid。最简单的方法就是直接查看网页源码,搜索cid,这样就可以得到单个视频的cid。然后就可以通过这个网址“/”+cid+“.xml”获取相关视频的弹幕。但问题是因为b站设置了弹幕,每个视频都有弹幕上限。如果数量达到一定数量,它将被清除。所以这个方法只能得到哈密瓜视频下方的当前弹幕。当然,如果你是批处理,需要用regular搜索cid,然后通过这个url处理xml结构文件。

对于评论,需要的是每个视频的 av 号。通过下面的网址,可以得到视频下的评论“/feedback?aid="+av号。此 URL 将返回第一页评论和三个 utf-8 格式的热门评论。还可以通过设置URL(&page=和&pagesize=)来设置最大评论数和第一页评论数。最大pagesize好像是300.

大概就是这样。完整的和具体的自动爬取代码我稍微编辑一下后会上传到github 查看全部

网站内容抓取(如何分析b站同一个视频下面的弹幕和评论(图))

因为学期的项目,需要分析b站同一个视频下的弹幕和评论,所以专门研究了一下,抓到了大概100多条视频评论和弹幕。

b站的视频有两个相关的id号,一个是cid,一个是大家都知道的AV号。你需要抓住弹幕的是cid。最简单的方法就是直接查看网页源码,搜索cid,这样就可以得到单个视频的cid。然后就可以通过这个网址“/”+cid+“.xml”获取相关视频的弹幕。但问题是因为b站设置了弹幕,每个视频都有弹幕上限。如果数量达到一定数量,它将被清除。所以这个方法只能得到哈密瓜视频下方的当前弹幕。当然,如果你是批处理,需要用regular搜索cid,然后通过这个url处理xml结构文件。

对于评论,需要的是每个视频的 av 号。通过下面的网址,可以得到视频下的评论“/feedback?aid="+av号。此 URL 将返回第一页评论和三个 utf-8 格式的热门评论。还可以通过设置URL(&page=和&pagesize=)来设置最大评论数和第一页评论数。最大pagesize好像是300.

大概就是这样。完整的和具体的自动爬取代码我稍微编辑一下后会上传到github

网站内容抓取(浅谈搜索引擎收录的抓取划定规矩有哪些?(图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 92 次浏览 • 2021-10-10 07:30

说说搜索引擎收录的爬取规则?说到SEO优化,就不得不说网站的收录问题。没有收录就不可能做SEO优化,所以不要收录 not SEO 这句话有一个积极的原则。今天,稍纵即逝的SEO于凡就和大家聊一聊搜索引擎收录的爬取规则。详细情况如下:

说说搜索引擎收录的爬取规则?

我们都知道,互联网上每天都有无数的新网页,大网站比小网站产生更多的新页面。搜索引擎倾向于从大型 网站 中搜索更多页面,因为大型 网站 通常收录更多高质量页面。搜索引擎更喜欢先抓取和采集大型网页。正是这种方式提醒站长做SEO,让更多的内容出现在网站上,强大的网页会引导搜索引擎频繁抓取和采集。这是SEO的长期计划。

搜索引擎抓取链中多个优质网页并进行优先排序

搜索引擎通过网页之间的链接关联在互联网上查找和抓取网页。大家都知道一个链接有投票功能。你得到的票数越多,搜索引擎就会关注它并抓住机会。谷歌提出的Page Rank算法可以根据链接关联对网页进行排名,并确定URL下载的顺序。因此,在SEO实践中,如果网页是收录,我们可以适当添加一条优质链。这里要特别注意“高品质”三个字。

从搜索引擎爬取的角度分析网站的采集规则

最近,发明了SEO外包优化。优化网站时,首页内容更新后,网站的排名偶尔会下降。当快照以某种方式返回时,排名恢复。仔细分析了百度站长平台的关键词和流量,发现在网站首页内容稳定的情况下,一定数量的关键词就有一定的点击量. 内容更新后,点击量下降。当快照返回时,排名再次上升。因此,推断百度在抓取和采集内容时会考虑用户体验,点击次数积极反映用户体验。

换句话说,搜索引擎将捕获并存储许多网页快照。如果旧网页快照更受用户欢迎,则不会收录新网页快照,因为搜索引擎总是考虑用户体验。

搜索引擎的资本不是无限的,他们也在竭尽全力的节省资本。。对于同样的网站,蜘蛛会根据网站的大小和更新频率来决定爬取的次数,并尽量用更少的资本来完成网站的更新策略。搜索引擎假设经常更新的页面在未来会经常更新。 查看全部

网站内容抓取(浅谈搜索引擎收录的抓取划定规矩有哪些?(图))

说说搜索引擎收录的爬取规则?说到SEO优化,就不得不说网站的收录问题。没有收录就不可能做SEO优化,所以不要收录 not SEO 这句话有一个积极的原则。今天,稍纵即逝的SEO于凡就和大家聊一聊搜索引擎收录的爬取规则。详细情况如下:

说说搜索引擎收录的爬取规则?

我们都知道,互联网上每天都有无数的新网页,大网站比小网站产生更多的新页面。搜索引擎倾向于从大型 网站 中搜索更多页面,因为大型 网站 通常收录更多高质量页面。搜索引擎更喜欢先抓取和采集大型网页。正是这种方式提醒站长做SEO,让更多的内容出现在网站上,强大的网页会引导搜索引擎频繁抓取和采集。这是SEO的长期计划。

搜索引擎抓取链中多个优质网页并进行优先排序

搜索引擎通过网页之间的链接关联在互联网上查找和抓取网页。大家都知道一个链接有投票功能。你得到的票数越多,搜索引擎就会关注它并抓住机会。谷歌提出的Page Rank算法可以根据链接关联对网页进行排名,并确定URL下载的顺序。因此,在SEO实践中,如果网页是收录,我们可以适当添加一条优质链。这里要特别注意“高品质”三个字。

从搜索引擎爬取的角度分析网站的采集规则

最近,发明了SEO外包优化。优化网站时,首页内容更新后,网站的排名偶尔会下降。当快照以某种方式返回时,排名恢复。仔细分析了百度站长平台的关键词和流量,发现在网站首页内容稳定的情况下,一定数量的关键词就有一定的点击量. 内容更新后,点击量下降。当快照返回时,排名再次上升。因此,推断百度在抓取和采集内容时会考虑用户体验,点击次数积极反映用户体验。

换句话说,搜索引擎将捕获并存储许多网页快照。如果旧网页快照更受用户欢迎,则不会收录新网页快照,因为搜索引擎总是考虑用户体验。

搜索引擎的资本不是无限的,他们也在竭尽全力的节省资本。。对于同样的网站,蜘蛛会根据网站的大小和更新频率来决定爬取的次数,并尽量用更少的资本来完成网站的更新策略。搜索引擎假设经常更新的页面在未来会经常更新。

网站内容抓取(不给nofollow加权重,你能看出什么吗?-八维教育)

网站优化 • 优采云 发表了文章 • 0 个评论 • 72 次浏览 • 2021-10-10 01:03

很多站长朋友只是认为在网站的内容中加入nofollow标签可以节省时间,让搜索引擎抓取其他内容,所以一些新站长为了改善所谓的网站 采集。我不评估这种方法的对与错。我刚刚引用了百度站长指南中的一句话,“不要给nofollow权重”。你能看到什么吗?也就是说,百度只是不计算nofollow下的链接权重,但是还是会被收录收录,省时间是无稽之谈。如果你的网站采集在一段时间内增长很大,那一定是外链建设或内容补充等其他工作做得很好,与nofollow标签无关。实际上,搜索引擎之所以不喜欢nofollow下的内容,是因为大部分内容毫无价值。蜘蛛会随着时间的推移增加访问这部分内容的周期,所以也给了我们一种不被收录里面的错觉。

删除标有 nofollow 的重复链接是否有效?

既然nofollow标签可以告诉搜索引擎什么该爬,什么不该爬,那为什么不用nofollow标签来屏蔽一些重复的链接,从而节省一定的爬行时间呢?当然这个方法没有什么害处,也会对网站造成很大的影响,但是一般来说这个方法的效果并不明显,因为根据我自己的操作经验,加入nofollow标签和它并不能像我们想象的那样节省时间,因为百度站长指着指南并明确表示蜘蛛会抓取链接。对于网站,不会重复出现,会给权重,只记录角色。蜘蛛删除重复的链接。这是一个基本的功能,因为现在更多的站长都是草根站长,对SEO不太了解。如果站长想要删除重复链接,则需要添加nofollow标签。因此,为了节省时间,没有必要使用nofollow标签去除重复链接。

nofollow标签与搜索引擎爬取的关系网站

我们可以使用nofollow标签来控制内部权重吗?

当我们知道nofollow标签可以屏蔽不必要的链接,然后整合网站的权重,一些网站管理员会倾向于使用nofollow标签来控制他们的网站的权重。一般的做法是网站管理员使用nofollow标签来屏蔽很多内页的内链,但这真的能集中网站内页的权重吗?显然,事情并没有那么简单。首先我想给大家解释一下,nofollow标签主要是外部的,而不是内部的。它的作用是删除一些没有任何价值的垃圾邮件或外部链接。如果用它来控制内页的权重,那就有点不靠谱了。因为当你想通过屏蔽内页的一些链接来整合首页的权重时,有没有想到另外一个我们需要注意的地方,那就是我们的友情链接区。交换友链的作用是互相传递权重。当我们专注于想象的重量时,它会不会散落在朋友的链上?显然,我们谁也不能保证谁都不愿意与他人分享来之不易的联系。而且,内部链接的屏蔽或多或少会影响内部页面的采集。总之,使用nofollow标签控制内页权重只能是站长自己的一厢情愿,实际操作价值不大。会不会散落在朋友圈里?显然,我们谁也不能保证谁都不愿意与他人分享来之不易的联系。而且,内部链接的屏蔽或多或少会影响内部页面的采集。总之,使用nofollow标签控制内页权重只能是站长自己的一厢情愿,实际操作价值不大。会不会散落在朋友圈里?显然,我们谁也不能保证谁都不愿意与他人分享来之不易的联系。而且,内部链接的屏蔽或多或少会影响内部页面的采集。总之,使用nofollow标签控制内页权重只能是站长自己的一厢情愿,实际操作价值不大。

在外链中嵌入nofollow标签是否会影响其物理特性?

一般来说,谷歌不会跟踪对这些网站的访问,这意味着谷歌不会通过这些链接发送PageRank或定位文字。实际上,使用nofollow 会阻止我们获取目标链接指向的网页。但是,如果其他站点在未使用 nofollow 的情况下链接到这些目标页面,或者如果它们的 URL 收录在提交给 Google 的站点地图中,这些页面可能仍会出现在索引中。请注意,其他搜索引擎可能会以与我们不同的方式处理 nofollow。

Nofollow 标签是网站管理员优化网站的一种方式。这会是一种欺骗手段吗?

当大家都知道nofollow标签可以屏蔽链接并设置网站的权重时。一些没有道德价值的站长在友情链接上做一些花招,在链接标签上加上rel="nofollow",在不降低权重的情况下欺骗别人的链接,这是司空见惯的。好在站长工具可以检测到这种做法,办法就是取消链接,“互相攻击”是没有必要的。

对比使用nofollow标签优化网站的构建,我们首先对nofollow标签有一个理性的认识。如果我们有正确的理解,我们的优化过程会更加顺畅。 查看全部

网站内容抓取(不给nofollow加权重,你能看出什么吗?-八维教育)

很多站长朋友只是认为在网站的内容中加入nofollow标签可以节省时间,让搜索引擎抓取其他内容,所以一些新站长为了改善所谓的网站 采集。我不评估这种方法的对与错。我刚刚引用了百度站长指南中的一句话,“不要给nofollow权重”。你能看到什么吗?也就是说,百度只是不计算nofollow下的链接权重,但是还是会被收录收录,省时间是无稽之谈。如果你的网站采集在一段时间内增长很大,那一定是外链建设或内容补充等其他工作做得很好,与nofollow标签无关。实际上,搜索引擎之所以不喜欢nofollow下的内容,是因为大部分内容毫无价值。蜘蛛会随着时间的推移增加访问这部分内容的周期,所以也给了我们一种不被收录里面的错觉。

删除标有 nofollow 的重复链接是否有效?

既然nofollow标签可以告诉搜索引擎什么该爬,什么不该爬,那为什么不用nofollow标签来屏蔽一些重复的链接,从而节省一定的爬行时间呢?当然这个方法没有什么害处,也会对网站造成很大的影响,但是一般来说这个方法的效果并不明显,因为根据我自己的操作经验,加入nofollow标签和它并不能像我们想象的那样节省时间,因为百度站长指着指南并明确表示蜘蛛会抓取链接。对于网站,不会重复出现,会给权重,只记录角色。蜘蛛删除重复的链接。这是一个基本的功能,因为现在更多的站长都是草根站长,对SEO不太了解。如果站长想要删除重复链接,则需要添加nofollow标签。因此,为了节省时间,没有必要使用nofollow标签去除重复链接。

nofollow标签与搜索引擎爬取的关系网站

我们可以使用nofollow标签来控制内部权重吗?

当我们知道nofollow标签可以屏蔽不必要的链接,然后整合网站的权重,一些网站管理员会倾向于使用nofollow标签来控制他们的网站的权重。一般的做法是网站管理员使用nofollow标签来屏蔽很多内页的内链,但这真的能集中网站内页的权重吗?显然,事情并没有那么简单。首先我想给大家解释一下,nofollow标签主要是外部的,而不是内部的。它的作用是删除一些没有任何价值的垃圾邮件或外部链接。如果用它来控制内页的权重,那就有点不靠谱了。因为当你想通过屏蔽内页的一些链接来整合首页的权重时,有没有想到另外一个我们需要注意的地方,那就是我们的友情链接区。交换友链的作用是互相传递权重。当我们专注于想象的重量时,它会不会散落在朋友的链上?显然,我们谁也不能保证谁都不愿意与他人分享来之不易的联系。而且,内部链接的屏蔽或多或少会影响内部页面的采集。总之,使用nofollow标签控制内页权重只能是站长自己的一厢情愿,实际操作价值不大。会不会散落在朋友圈里?显然,我们谁也不能保证谁都不愿意与他人分享来之不易的联系。而且,内部链接的屏蔽或多或少会影响内部页面的采集。总之,使用nofollow标签控制内页权重只能是站长自己的一厢情愿,实际操作价值不大。会不会散落在朋友圈里?显然,我们谁也不能保证谁都不愿意与他人分享来之不易的联系。而且,内部链接的屏蔽或多或少会影响内部页面的采集。总之,使用nofollow标签控制内页权重只能是站长自己的一厢情愿,实际操作价值不大。

在外链中嵌入nofollow标签是否会影响其物理特性?

一般来说,谷歌不会跟踪对这些网站的访问,这意味着谷歌不会通过这些链接发送PageRank或定位文字。实际上,使用nofollow 会阻止我们获取目标链接指向的网页。但是,如果其他站点在未使用 nofollow 的情况下链接到这些目标页面,或者如果它们的 URL 收录在提交给 Google 的站点地图中,这些页面可能仍会出现在索引中。请注意,其他搜索引擎可能会以与我们不同的方式处理 nofollow。

Nofollow 标签是网站管理员优化网站的一种方式。这会是一种欺骗手段吗?

当大家都知道nofollow标签可以屏蔽链接并设置网站的权重时。一些没有道德价值的站长在友情链接上做一些花招,在链接标签上加上rel="nofollow",在不降低权重的情况下欺骗别人的链接,这是司空见惯的。好在站长工具可以检测到这种做法,办法就是取消链接,“互相攻击”是没有必要的。

对比使用nofollow标签优化网站的构建,我们首先对nofollow标签有一个理性的认识。如果我们有正确的理解,我们的优化过程会更加顺畅。

网站内容抓取(网站打开速度慢对seo有影响吗?有哪些影响?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 73 次浏览 • 2021-10-10 00:51

网站打开速度慢对seo有影响吗?

随着互联网的不断发展,越来越多的企业开始关注网站。他们都想让网站在搜索引擎上有很好的排名,从而获得大量的流量。是时候优化网站了。很多SEO人员会优化网站的内容、内链、外链,却忽略了网站打开速度的优化,导致网站优化无法实现想要的效果。

那么,网站打开速度对SEO优化有什么影响?

1、影响用户体验

网站优化的最终目的是为了用户体验,因为用户浏览网站的目的是为了解决他们的需求,如果一个网站的打开速度太慢,那么用户会直接关闭网站,从而增加网站的跳出率。

2、影响搜索引擎蜘蛛抓取

<p>如果网站打开速度太慢或者网站打不开,都会影响搜索引擎蜘蛛的抓取。时间长了,搜索引擎会认为网站的质量太低,从此以后就再也抢不到网站的内容,影响 查看全部

网站内容抓取(网站打开速度慢对seo有影响吗?有哪些影响?)

网站打开速度慢对seo有影响吗?

随着互联网的不断发展,越来越多的企业开始关注网站。他们都想让网站在搜索引擎上有很好的排名,从而获得大量的流量。是时候优化网站了。很多SEO人员会优化网站的内容、内链、外链,却忽略了网站打开速度的优化,导致网站优化无法实现想要的效果。

那么,网站打开速度对SEO优化有什么影响?

1、影响用户体验

网站优化的最终目的是为了用户体验,因为用户浏览网站的目的是为了解决他们的需求,如果一个网站的打开速度太慢,那么用户会直接关闭网站,从而增加网站的跳出率。

2、影响搜索引擎蜘蛛抓取

<p>如果网站打开速度太慢或者网站打不开,都会影响搜索引擎蜘蛛的抓取。时间长了,搜索引擎会认为网站的质量太低,从此以后就再也抢不到网站的内容,影响

网站内容抓取( 如何通过独立站抓住买家的心?谷歌移动优先索引)

网站优化 • 优采云 发表了文章 • 0 个评论 • 173 次浏览 • 2021-10-09 19:28

如何通过独立站抓住买家的心?谷歌移动优先索引)

独立站是企业的“前端责任”,以外观和实力吸引客户。我们从网站内容、用户体验、网站曝光三个方面来分析如何通过独立站俘获买家的心。

一、实用网站内容

1、 通过谷歌分析工具,我们可以了解客户的访问习惯和用户画像,从而设计出更符合访问者口味的产品营销内容。

2、确保客户在登录网页时可以快速找到需要的信息,并提供对买家“真正有用”的信息,以便留住他们。

3、以下是访客第一次离开网站的原因。您必须避免这些内容。

二、网页质量得分是关键

1、灵活打造品牌形象和故事

摆脱建站千篇一律的模板,通过精美的图片和视频,多角度、多形式,更生动地讲述你的产品故事。

优秀的网站案例

2、谷歌移动优先索引,建议搭建全站AMP网站

AMP,英文全称是Accelerated Mobile Pages,中文翻译是“Mobile Accelerated Pages”。网站在手机上快速加载,几秒内即可访问内容,轻松导航。

Focus Leader 将于 12 月推出全站 AMP网站。想了解更多的朋友可以扫描领导小姐末尾文章的微信。

3、查询按钮应该很容易在每个页面上找到

导航到顶部,产品页面,文章页面,让它无处不在。

4、如果要在小语种国家发布,网站应该有对应的语言页面

页面语言要符合目标市场的产品语言习惯,不能有低级拼写错误,让访问者感觉不专业。

三、谷歌抓取网站基本原理

独立站是品牌长期发展的基石,不断增强消费者粘性,逐步建立起长期的信任关系。

如何让网站信息更好地被谷歌捕获?

1、确保您的 网站 在 Google 的索引中。您可以通过注册 Search Console(Google URL 检查工具)进行确认。

2、 有很多超链接从其他网站指向你的网站,俗称:发送链接。与优质的网站建立跨链关系,会增加网站的权重和排名。

3、向 Google 提交站点地图。站点地图是网站上的一个文档,可以通知网站的搜索引擎有新的或更新的网页。

领先云平台后台截图

帮助谷歌了解你对网站的基本原理

1、确认 Googlebot 始终可以访问您使用的 JavaScript、CSS 和图像文件网站;同时,robots.txt文件明确允许Googlebot抓取哪些页面,哪些页面Googlebot禁止抓取。

领先云平台后台截图

2、创建独特而准确的页面标题,创建适当的标题和摘要以显示在搜索结果中,并使用标题标签来强调重要的文本。

3、使用高质量的图像/视频并为其添加描述性标题、描述、文件名和文本。

4、 具有清晰的页面层次结构和导航设计。

Focus Lead拥有丰富的外贸网站建设经验,北京外贸建设站、上海外贸建设站、广州外贸建设站、深圳外贸建设站、佛山外贸建设站、福建外贸建设站、浙江外贸建设站、山东外贸建设站、江苏外贸建设站...... 查看全部

网站内容抓取(

如何通过独立站抓住买家的心?谷歌移动优先索引)

独立站是企业的“前端责任”,以外观和实力吸引客户。我们从网站内容、用户体验、网站曝光三个方面来分析如何通过独立站俘获买家的心。

一、实用网站内容

1、 通过谷歌分析工具,我们可以了解客户的访问习惯和用户画像,从而设计出更符合访问者口味的产品营销内容。

2、确保客户在登录网页时可以快速找到需要的信息,并提供对买家“真正有用”的信息,以便留住他们。

3、以下是访客第一次离开网站的原因。您必须避免这些内容。

二、网页质量得分是关键

1、灵活打造品牌形象和故事

摆脱建站千篇一律的模板,通过精美的图片和视频,多角度、多形式,更生动地讲述你的产品故事。

优秀的网站案例

2、谷歌移动优先索引,建议搭建全站AMP网站

AMP,英文全称是Accelerated Mobile Pages,中文翻译是“Mobile Accelerated Pages”。网站在手机上快速加载,几秒内即可访问内容,轻松导航。

Focus Leader 将于 12 月推出全站 AMP网站。想了解更多的朋友可以扫描领导小姐末尾文章的微信。

3、查询按钮应该很容易在每个页面上找到

导航到顶部,产品页面,文章页面,让它无处不在。

4、如果要在小语种国家发布,网站应该有对应的语言页面

页面语言要符合目标市场的产品语言习惯,不能有低级拼写错误,让访问者感觉不专业。

三、谷歌抓取网站基本原理

独立站是品牌长期发展的基石,不断增强消费者粘性,逐步建立起长期的信任关系。

如何让网站信息更好地被谷歌捕获?

1、确保您的 网站 在 Google 的索引中。您可以通过注册 Search Console(Google URL 检查工具)进行确认。

2、 有很多超链接从其他网站指向你的网站,俗称:发送链接。与优质的网站建立跨链关系,会增加网站的权重和排名。

3、向 Google 提交站点地图。站点地图是网站上的一个文档,可以通知网站的搜索引擎有新的或更新的网页。

领先云平台后台截图

帮助谷歌了解你对网站的基本原理

1、确认 Googlebot 始终可以访问您使用的 JavaScript、CSS 和图像文件网站;同时,robots.txt文件明确允许Googlebot抓取哪些页面,哪些页面Googlebot禁止抓取。

领先云平台后台截图

2、创建独特而准确的页面标题,创建适当的标题和摘要以显示在搜索结果中,并使用标题标签来强调重要的文本。

3、使用高质量的图像/视频并为其添加描述性标题、描述、文件名和文本。

4、 具有清晰的页面层次结构和导航设计。

Focus Lead拥有丰富的外贸网站建设经验,北京外贸建设站、上海外贸建设站、广州外贸建设站、深圳外贸建设站、佛山外贸建设站、福建外贸建设站、浙江外贸建设站、山东外贸建设站、江苏外贸建设站......

网站内容抓取(几种就是吸引百度蜘蛛更快的爬行网站吗?小编来)

网站优化 • 优采云 发表了文章 • 0 个评论 • 84 次浏览 • 2021-10-09 19:26

百度蜘蛛就是大家所说的搜索引擎程序。百度蜘蛛的主要作用是抓取网站上的内容。相信大家都知道百度蜘蛛的爬取和爬取频率直接影响到网站的排名、权重等,所以大家可以理解百度蜘蛛的作用。另外,你能理解如何让百度蜘蛛爬得更快网站吗?今天小编就给大家详细介绍一下!

1.制作网站地图

站点地图有XML和HTML两种,可以在站点上显示新的内容,并屏蔽百度蜘蛛不需要抓取的内容,让百度蜘蛛更准确地找到站点上的关键内容进行抓取。

2. 自动提交 URL

如果你想让百度蜘蛛抓取你的网站,把网址频繁提交给每个网站也是一个不错的方法。如果条件允许,可以试试这个方法。

3.更新内容

大家都知道,新站和旧站的更新频率是没法比的。一般来说,新网站在更新内容时需要更新更多高质量的原创文章,而老网站排名稳定后,大家只需要定期更新内容,百度蜘蛛的习惯也是是网站的管理员“教”出来的,所以不管是新站还是老站,一定要增加网站的内容,才能更好的吸引蜘蛛爬取你的网站。

4.外部链接

外链可以说是一个很好的吸引百度蜘蛛的方式。常见的外链有论坛、QQ群、微博等。但是大家一定要找一个好的外链来发布,这样效果才能好,外链一定要细化,不能广撒网。

以上描述是一些常见的吸引百度蜘蛛爬行的方式。有时间的话不妨试试。 查看全部

网站内容抓取(几种就是吸引百度蜘蛛更快的爬行网站吗?小编来)

百度蜘蛛就是大家所说的搜索引擎程序。百度蜘蛛的主要作用是抓取网站上的内容。相信大家都知道百度蜘蛛的爬取和爬取频率直接影响到网站的排名、权重等,所以大家可以理解百度蜘蛛的作用。另外,你能理解如何让百度蜘蛛爬得更快网站吗?今天小编就给大家详细介绍一下!

1.制作网站地图

站点地图有XML和HTML两种,可以在站点上显示新的内容,并屏蔽百度蜘蛛不需要抓取的内容,让百度蜘蛛更准确地找到站点上的关键内容进行抓取。

2. 自动提交 URL

如果你想让百度蜘蛛抓取你的网站,把网址频繁提交给每个网站也是一个不错的方法。如果条件允许,可以试试这个方法。

3.更新内容

大家都知道,新站和旧站的更新频率是没法比的。一般来说,新网站在更新内容时需要更新更多高质量的原创文章,而老网站排名稳定后,大家只需要定期更新内容,百度蜘蛛的习惯也是是网站的管理员“教”出来的,所以不管是新站还是老站,一定要增加网站的内容,才能更好的吸引蜘蛛爬取你的网站。

4.外部链接

外链可以说是一个很好的吸引百度蜘蛛的方式。常见的外链有论坛、QQ群、微博等。但是大家一定要找一个好的外链来发布,这样效果才能好,外链一定要细化,不能广撒网。

以上描述是一些常见的吸引百度蜘蛛爬行的方式。有时间的话不妨试试。

网站内容抓取( 网站内容是否被搜索引擎抓取是网站有没有效果的前题条件)

网站优化 • 优采云 发表了文章 • 0 个评论 • 65 次浏览 • 2021-10-09 01:24

网站内容是否被搜索引擎抓取是网站有没有效果的前题条件)

网站内容是否被搜索引擎抓取是网站是否有效的前提,这也是为什么很多新的网站不容易被百度抓取,导致一些站长到处去寻找答案并找到方法。其实被百度抓到是有办法的。你可以找到专业的事情去做。之前写过很多相关的文章,这里就不讨论了。是的,我们今天讨论的问题也是很多站长关心的问题,就是如何提高网站内容被百度抓取的频率?

网站想要被百度抓取,最重要的是网站是否符合抓取要求。我们需要先了解百度为什么要抓取你的内容,因为你的网站很有用。别人用百度搜索问题的时候,找到你的网站,然后就可以帮助用户了。这就是我们 常说您的 网站 需要有价值。

有人说我以为我可以做一个单页搜索引擎收录。那是以前。那至少是三年前的事了。现在你可以为百度制作一个简单的单页搜索引擎了。试试看?至少有一定的难度。所以,对我们来说最重要的是丰富网站自身的内容。只有有价值,才有利于搜索引擎抓住你。

我只是在谈论爬行。有的网站每天的抓取频率可能只有个位数,而有的网站可能有三位数或四位数的抓取频率。为什么会有这么大的区别?

第一:网站内容的丰富性,如果你的网站有三千篇文章,而别人的网站有三篇文章,你的< @网站一共三篇文章 @网站 就算不更新,抓取频率也不会太差。如果你的网站只是几个文章,不管你怎么做,爬取频率都限制在几次。这时候就需要增加内容量了。

第二:内容的更新频率,定期更新网站内容还是很重要的。一旦你的网站定期更新一段时间,百度的抓取频率会大大提高。.

第三:网站的外链状态不是最重要的,但也会影响网站被搜索引擎抓取的频率。外部链接的质量是最重要的。其实就是数量。我们已经强调过很多次了。

当然,还有其他的因素,以后有时间再和大家分享。 查看全部

网站内容抓取(

网站内容是否被搜索引擎抓取是网站有没有效果的前题条件)

网站内容是否被搜索引擎抓取是网站是否有效的前提,这也是为什么很多新的网站不容易被百度抓取,导致一些站长到处去寻找答案并找到方法。其实被百度抓到是有办法的。你可以找到专业的事情去做。之前写过很多相关的文章,这里就不讨论了。是的,我们今天讨论的问题也是很多站长关心的问题,就是如何提高网站内容被百度抓取的频率?