文章采集

文章采集(php采集文章图片不显示的解决办法:1、根据关键字采集百度搜寻结果)

采集交流 • 优采云 发表了文章 • 0 个评论 • 176 次浏览 • 2021-10-20 14:17

php采集文章图片不显示的解决方法:1、根据关键字采集百度搜索结果; 2、把采集放到Html中,根据定义的域名做批量转换即可。

本文运行环境:windows7系统,PHP7.版本1,DELL G3电脑

php采集文章图片不显示怎么办?

PHP CURL采集百度搜索结果图片不显示问题的解决方法

1.根据关键字采集百度搜索结果

根据关键字采集百度搜索结果,可以使用curl来实现,代码如下:

<p>

</p>

输出后发现有些图片无法显示

2.采集显示后图片不显示原因分析

直接在百度搜索,页面可以显示图片。使用firebug查看图片路径,发现采集的图片域名与百度搜索的图片域名不同。

采集返回的图片域名

用于普通搜索的图像域

查看采集和正常搜索html,发现有不同的域名转换js

采集

普通搜索

<p>var list = {

"graph.baidu.com": "https://sp0.baidu.com/-aYHfD0a2gU2pMbgoY3K",

"t1.baidu.com":"https://ss0.baidu.com/6ON1bjeh1BF3odCf",

"t2.baidu.com":"https://ss1.baidu.com/6OZ1bjeh1BF3odCf",

"t3.baidu.com":"https://ss2.baidu.com/6OV1bjeh1BF3odCf",

"t10.baidu.com":"https://ss0.baidu.com/6ONWsjip0QIZ8tyhnq",

"t11.baidu.com":"https://ss1.baidu.com/6ONXsjip0QIZ8tyhnq",

"t12.baidu.com":"https://ss2.baidu.com/6ONYsjip0QIZ8tyhnq",

"i7.baidu.com":"https://ss0.baidu.com/73F1bjeh1BF3odCf",

"i8.baidu.com":"https://ss0.baidu.com/73x1bjeh1BF3odCf",

"i9.baidu.com":"https://ss0.baidu.com/73t1bjeh1BF3odCf",

};

</p>

因此,根据源地址、IP、header等参数可以断定,如果是采集,百度会返回不同的js。

3.采集图片不显示后的解决方法

根据定义的域名批量传输采集中的html。

<p>

</p>

添加域名转换后,所有图片均可正常显示。

推荐学习:《PHP视频教程》

以上是php采集文章的详细内容,图片没有说明怎么做。更多详情请关注php中文网等相关文章!

免责声明:本文由原创发表于php中文网。转载请注明出处。感谢您的尊重!如果您有任何问题,请联系我们 查看全部

文章采集(php采集文章图片不显示的解决办法:1、根据关键字采集百度搜寻结果)

php采集文章图片不显示的解决方法:1、根据关键字采集百度搜索结果; 2、把采集放到Html中,根据定义的域名做批量转换即可。

本文运行环境:windows7系统,PHP7.版本1,DELL G3电脑

php采集文章图片不显示怎么办?

PHP CURL采集百度搜索结果图片不显示问题的解决方法

1.根据关键字采集百度搜索结果

根据关键字采集百度搜索结果,可以使用curl来实现,代码如下:

<p>

</p>

输出后发现有些图片无法显示

2.采集显示后图片不显示原因分析

直接在百度搜索,页面可以显示图片。使用firebug查看图片路径,发现采集的图片域名与百度搜索的图片域名不同。

采集返回的图片域名

用于普通搜索的图像域

查看采集和正常搜索html,发现有不同的域名转换js

采集

普通搜索

<p>var list = {

"graph.baidu.com": "https://sp0.baidu.com/-aYHfD0a2gU2pMbgoY3K",

"t1.baidu.com":"https://ss0.baidu.com/6ON1bjeh1BF3odCf",

"t2.baidu.com":"https://ss1.baidu.com/6OZ1bjeh1BF3odCf",

"t3.baidu.com":"https://ss2.baidu.com/6OV1bjeh1BF3odCf",

"t10.baidu.com":"https://ss0.baidu.com/6ONWsjip0QIZ8tyhnq",

"t11.baidu.com":"https://ss1.baidu.com/6ONXsjip0QIZ8tyhnq",

"t12.baidu.com":"https://ss2.baidu.com/6ONYsjip0QIZ8tyhnq",

"i7.baidu.com":"https://ss0.baidu.com/73F1bjeh1BF3odCf",

"i8.baidu.com":"https://ss0.baidu.com/73x1bjeh1BF3odCf",

"i9.baidu.com":"https://ss0.baidu.com/73t1bjeh1BF3odCf",

};

</p>

因此,根据源地址、IP、header等参数可以断定,如果是采集,百度会返回不同的js。

3.采集图片不显示后的解决方法

根据定义的域名批量传输采集中的html。

<p>

</p>

添加域名转换后,所有图片均可正常显示。

推荐学习:《PHP视频教程》

以上是php采集文章的详细内容,图片没有说明怎么做。更多详情请关注php中文网等相关文章!

免责声明:本文由原创发表于php中文网。转载请注明出处。感谢您的尊重!如果您有任何问题,请联系我们

文章采集(一下如何用优采云采集器采集器采集文章?的使用方法)

采集交流 • 优采云 发表了文章 • 0 个评论 • 194 次浏览 • 2021-10-14 11:14

优采云采集器如何采集文章?有时候我们看到一个网站的文章,就想保存这些文章。一张一张的复制保存很麻烦。这时候就需要使用优采云采集器保存文章采集,下面分享优采云的用法

有时我们看到一个网站的文章,就想保存这些文章。一张一张的复制保存很麻烦。这时候就需要使用优采云采集器保存文章采集。下面是如何使用优采云采集器采集文章。

软件名称:

QQ宠物经典360题补充(累积更新)

软件大小:

更新时间:

2009-04-27立即下载

第一步,下载采集 URL,下载优采云采集器,打开即可新建一个任意任务名称的任务。将需要采集的网站文章列表页面的URL添加到起始URL。从图中可以看出,列表页有34页,每页有N篇文章文章。

列表页面会获取一级URL,添加多级URL获取二级URL(文章page URL)

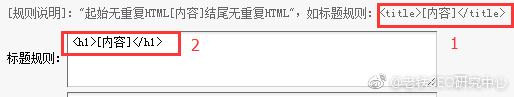

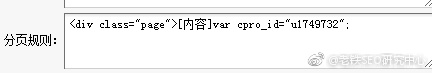

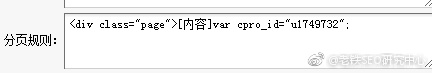

设置要通过分页检索的列表。三处分别为:分页源代码前后中间位置。此步骤用于获取列表页链接,因为列表页共有 34 个。设置好后保存。

URL获取选项,此步骤用于获取列表页文章页面的链接,根据自己的需要设置需要拦截的部分,根据需要设置收录或排除某些字符URL 的结构。如果为空,则没有限制,设置后保存。

设置好link采集规则后,可以测试URL,根据测试结果调整规则。看图可以看到采集链接规则已经成功,从初始链接到综合列表页,再到列表页采集上的文章页链接。

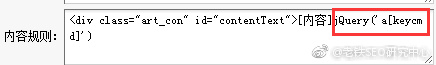

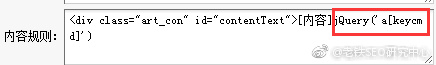

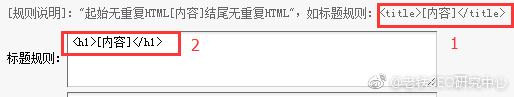

第二步是采集的内容。首先修改标题规则,在页面源码中找到标题代码,将标题前后的标题剪掉。节省。

内容修改采集规则类似于title规则,也是在源码中找到的内容前后的代码。这里的内容会有一些其他的html标签,所以你必须添加一个html标签排除规则。

完成测试后,查看结果并从测试结果中调试规则,直到测试结果是您想要的。

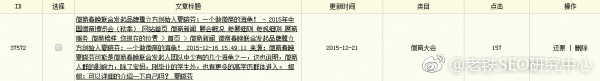

第三步是采集导出。1、2的前两步设置规则,最后导出文章。首先制作一个导出的模板。

然后选择方法二,将每篇文章文章记录成txt文本,自己保存位置,选择刚刚制作的模板导出模板。保存的文件名以文章的标题命名。其他默认,保存。

勾选采集 URL、采集内容3个选项框并发布,然后启动采集。完成后,文本会自动生成在刚刚保存的文件夹中。

优采云采集器采集文章教程到此结束。由于每一个网站都不同,这里只能使用一个网站。@>演示只是一种思维方式。您需要 采集文章 才能灵活。

上面是优采云采集器怎么样采集文章?更多详情请关注其他相关html中文网站文章! 查看全部

文章采集(一下如何用优采云采集器采集器采集文章?的使用方法)

优采云采集器如何采集文章?有时候我们看到一个网站的文章,就想保存这些文章。一张一张的复制保存很麻烦。这时候就需要使用优采云采集器保存文章采集,下面分享优采云的用法

有时我们看到一个网站的文章,就想保存这些文章。一张一张的复制保存很麻烦。这时候就需要使用优采云采集器保存文章采集。下面是如何使用优采云采集器采集文章。

软件名称:

QQ宠物经典360题补充(累积更新)

软件大小:

更新时间:

2009-04-27立即下载

第一步,下载采集 URL,下载优采云采集器,打开即可新建一个任意任务名称的任务。将需要采集的网站文章列表页面的URL添加到起始URL。从图中可以看出,列表页有34页,每页有N篇文章文章。

列表页面会获取一级URL,添加多级URL获取二级URL(文章page URL)

设置要通过分页检索的列表。三处分别为:分页源代码前后中间位置。此步骤用于获取列表页链接,因为列表页共有 34 个。设置好后保存。

URL获取选项,此步骤用于获取列表页文章页面的链接,根据自己的需要设置需要拦截的部分,根据需要设置收录或排除某些字符URL 的结构。如果为空,则没有限制,设置后保存。

设置好link采集规则后,可以测试URL,根据测试结果调整规则。看图可以看到采集链接规则已经成功,从初始链接到综合列表页,再到列表页采集上的文章页链接。

第二步是采集的内容。首先修改标题规则,在页面源码中找到标题代码,将标题前后的标题剪掉。节省。

内容修改采集规则类似于title规则,也是在源码中找到的内容前后的代码。这里的内容会有一些其他的html标签,所以你必须添加一个html标签排除规则。

完成测试后,查看结果并从测试结果中调试规则,直到测试结果是您想要的。

第三步是采集导出。1、2的前两步设置规则,最后导出文章。首先制作一个导出的模板。

然后选择方法二,将每篇文章文章记录成txt文本,自己保存位置,选择刚刚制作的模板导出模板。保存的文件名以文章的标题命名。其他默认,保存。

勾选采集 URL、采集内容3个选项框并发布,然后启动采集。完成后,文本会自动生成在刚刚保存的文件夹中。

优采云采集器采集文章教程到此结束。由于每一个网站都不同,这里只能使用一个网站。@>演示只是一种思维方式。您需要 采集文章 才能灵活。

上面是优采云采集器怎么样采集文章?更多详情请关注其他相关html中文网站文章!

文章采集(优采云大数据采集网站:使用功能点:URL列表信息采集 )

采集交流 • 优采云 发表了文章 • 0 个评论 • 204 次浏览 • 2021-09-08 13:23

)

采集网站:

使用功能点:

网址

分页列表信息采集

搜狗微信搜索:搜狗微信搜索是搜狗于2014年6月9日推出的微信公众平台。“微信搜索”支持搜索微信公众号和微信文章,可以通过关键词搜索相关微信公众号@,或文章微信公众号推送。不仅是PC端,搜狗手机搜索客户端也会推荐相关微信公众号。

搜狗微信文章采集数据说明:本文在搜狗微信-搜索-优采云大数据的文章信息采集进行。本文仅以“搜狗微信-搜索-优采云大数据的文章信息采集”为例。实际操作中,您可以根据自己的需要,将搜狗微信的搜索词更改为执行数据采集。

搜狗微信文章采集detail采集字段说明:微信文章title、微信文章keywords、微信文章generalization、微信公众号、微信文章发布时间、微信文章地址。

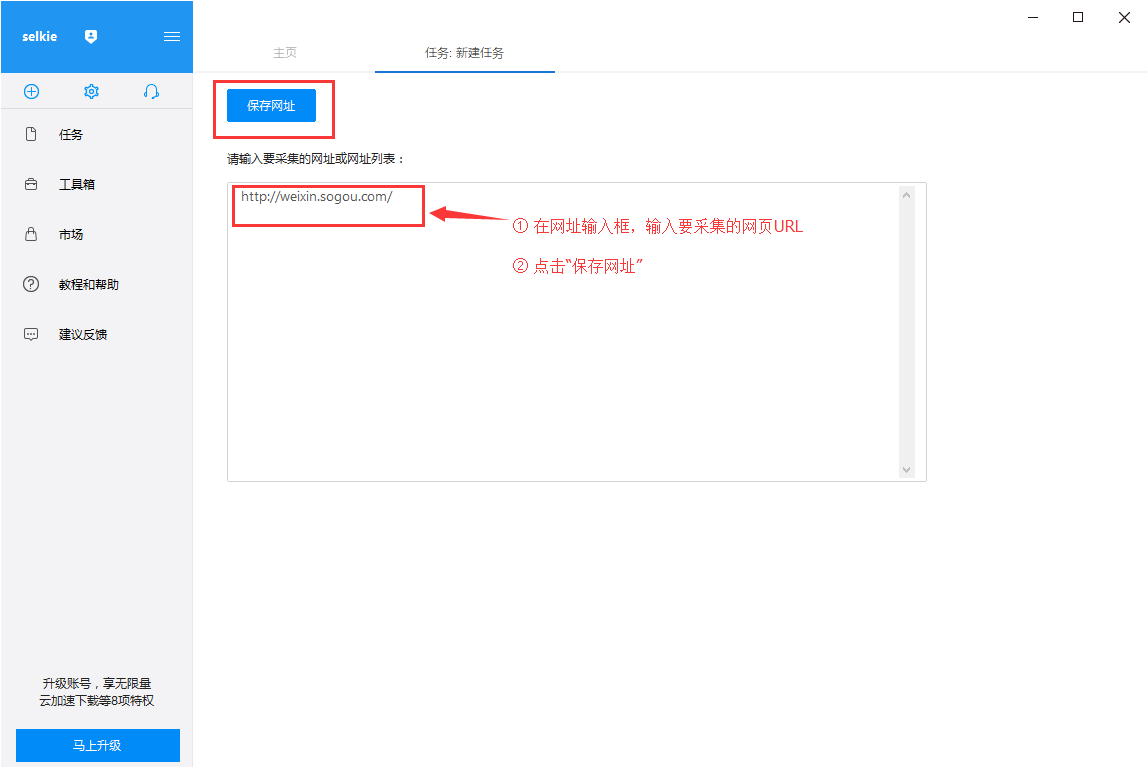

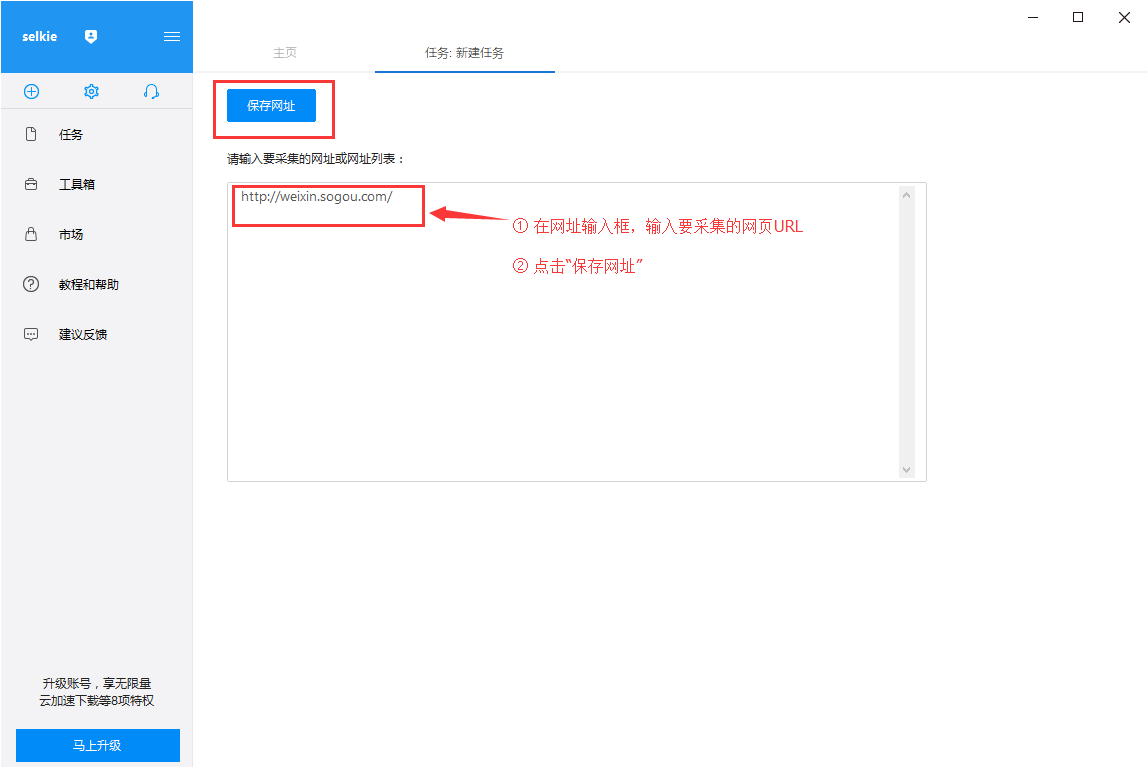

第一步:创建采集task

1)进入主界面,选择“自定义模式”

2)将采集的网址复制粘贴到网站输入框中,点击“保存网址”

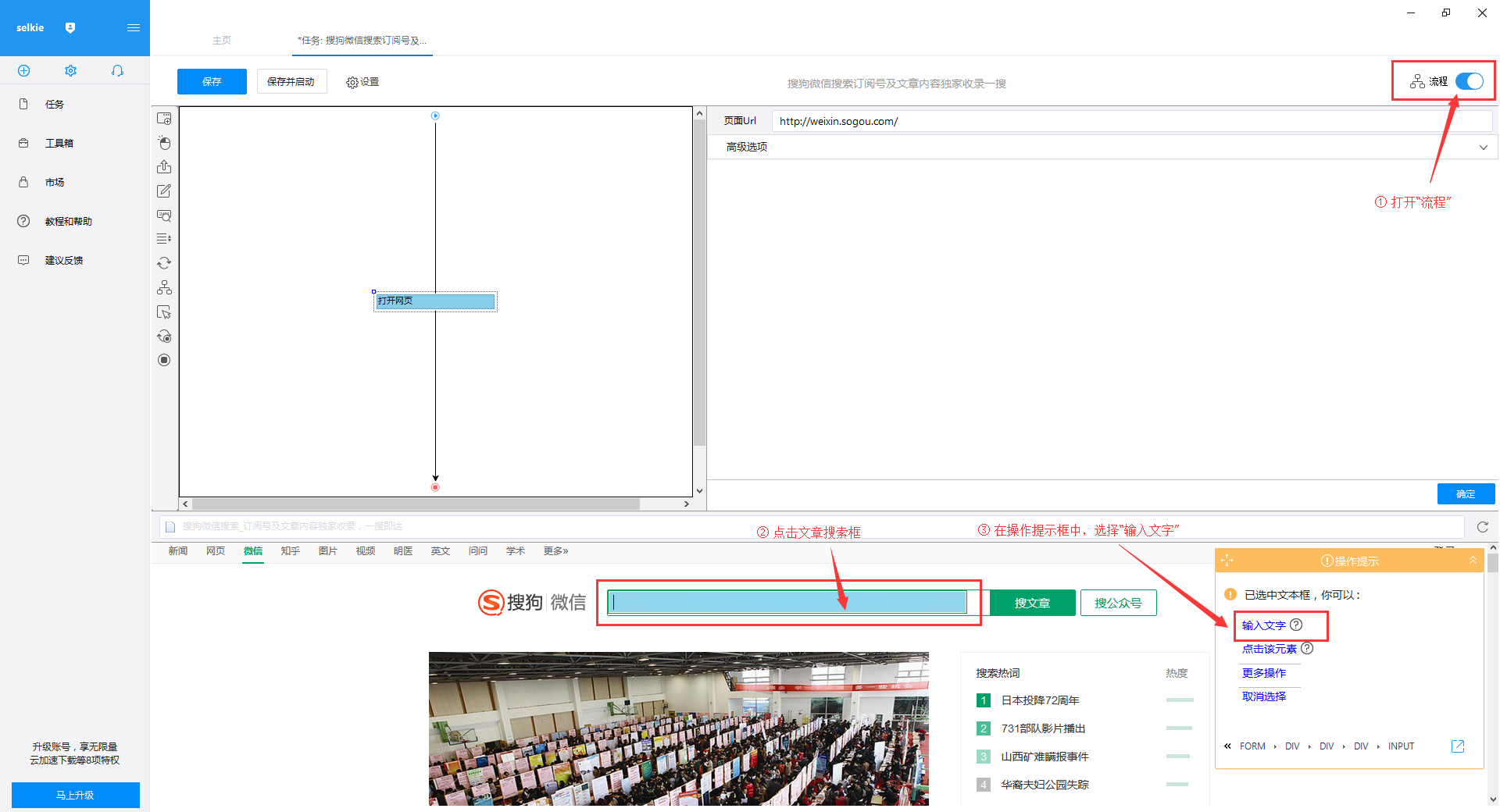

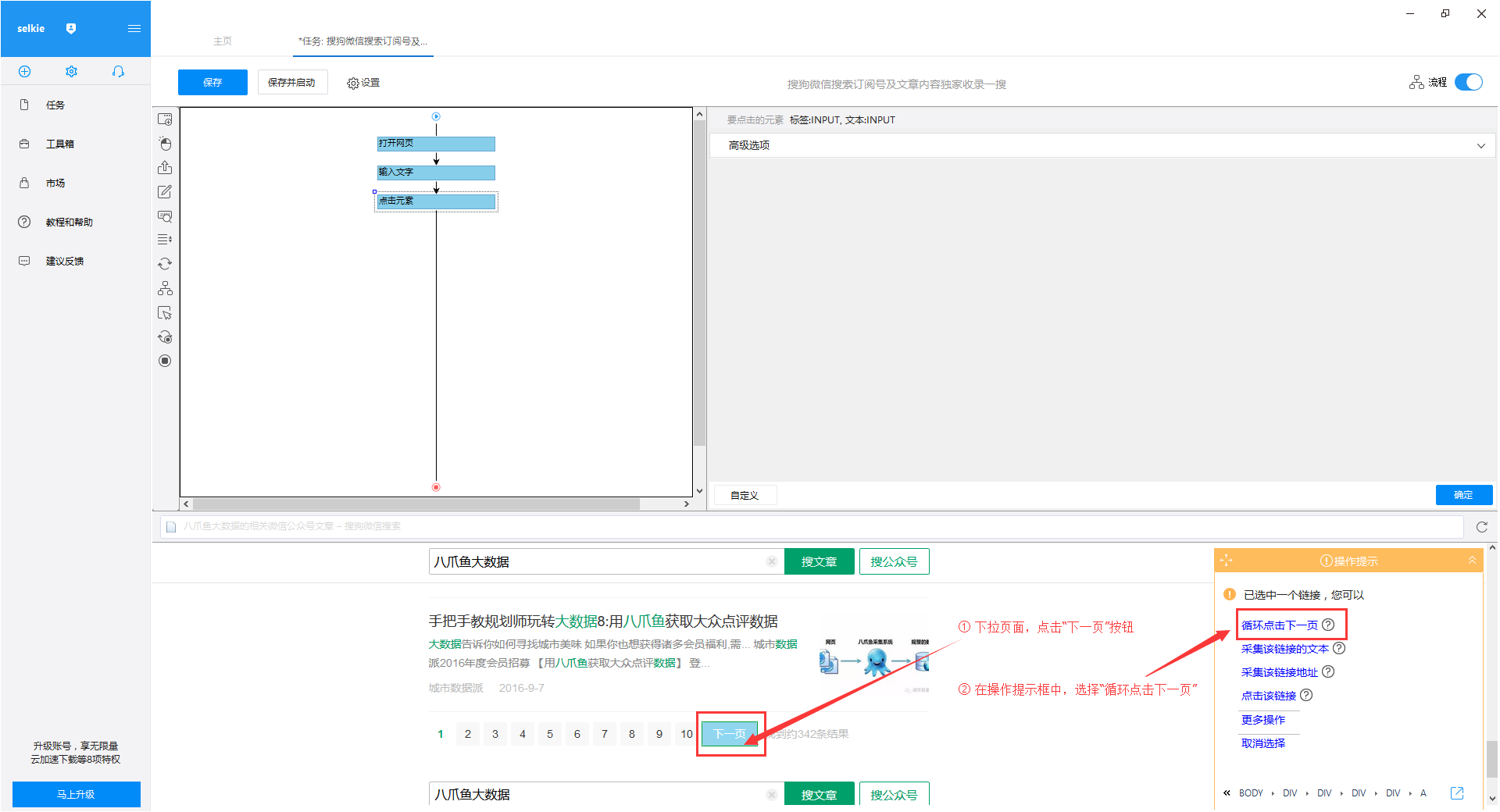

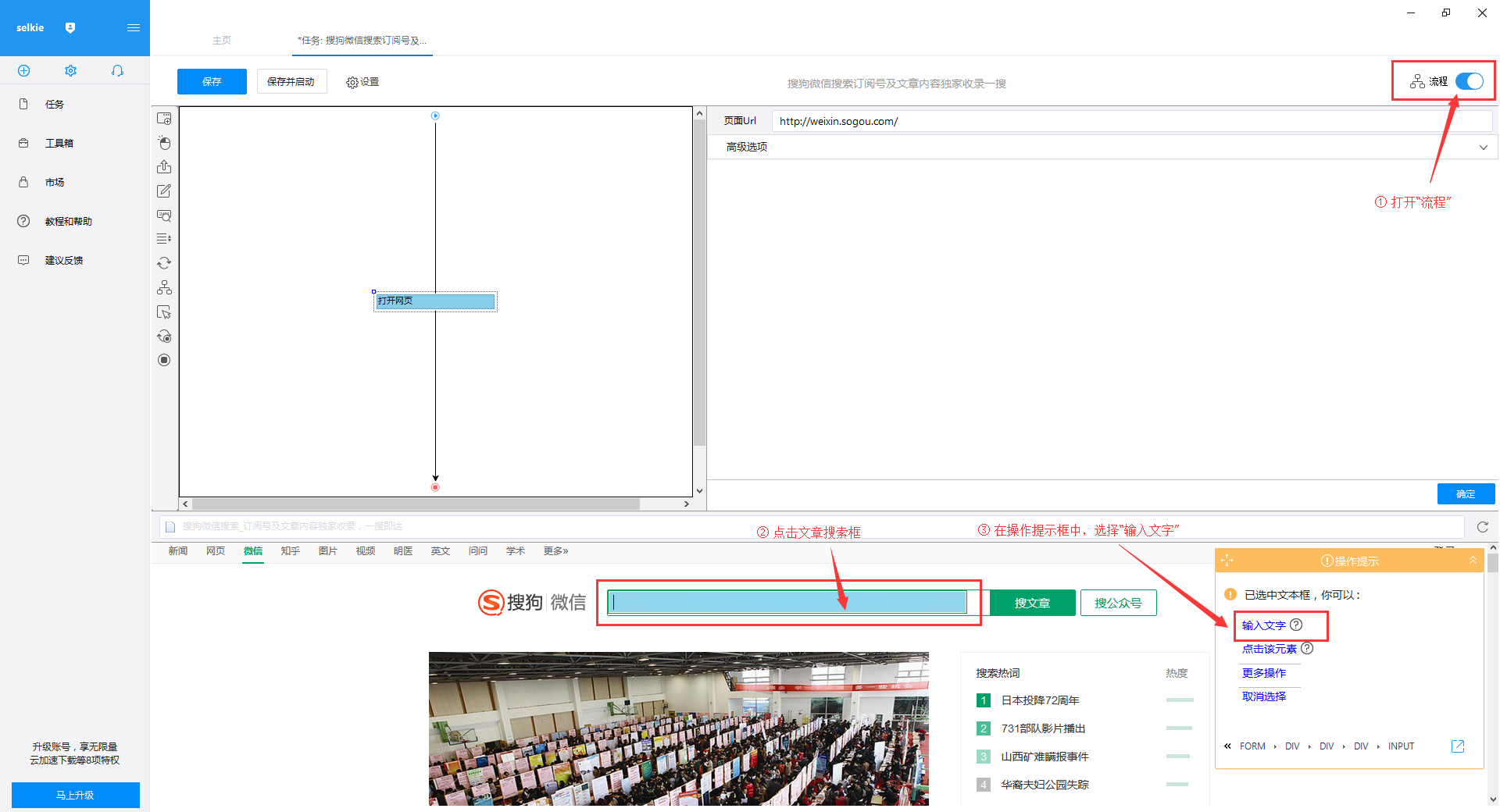

第 2 步:创建翻页循环

1)打开右上角的“进程”。点击页面文章搜索框,在右侧操作提示框中选择“输入文字”

2)输入要搜索的文章信息,这里以搜索“优采云大数据”为例,输入完成后点击“确定”按钮

3)“优采云大数据”会自动填写搜索框,点击“search文章”按钮,在操作提示框中选择“点击此按钮”

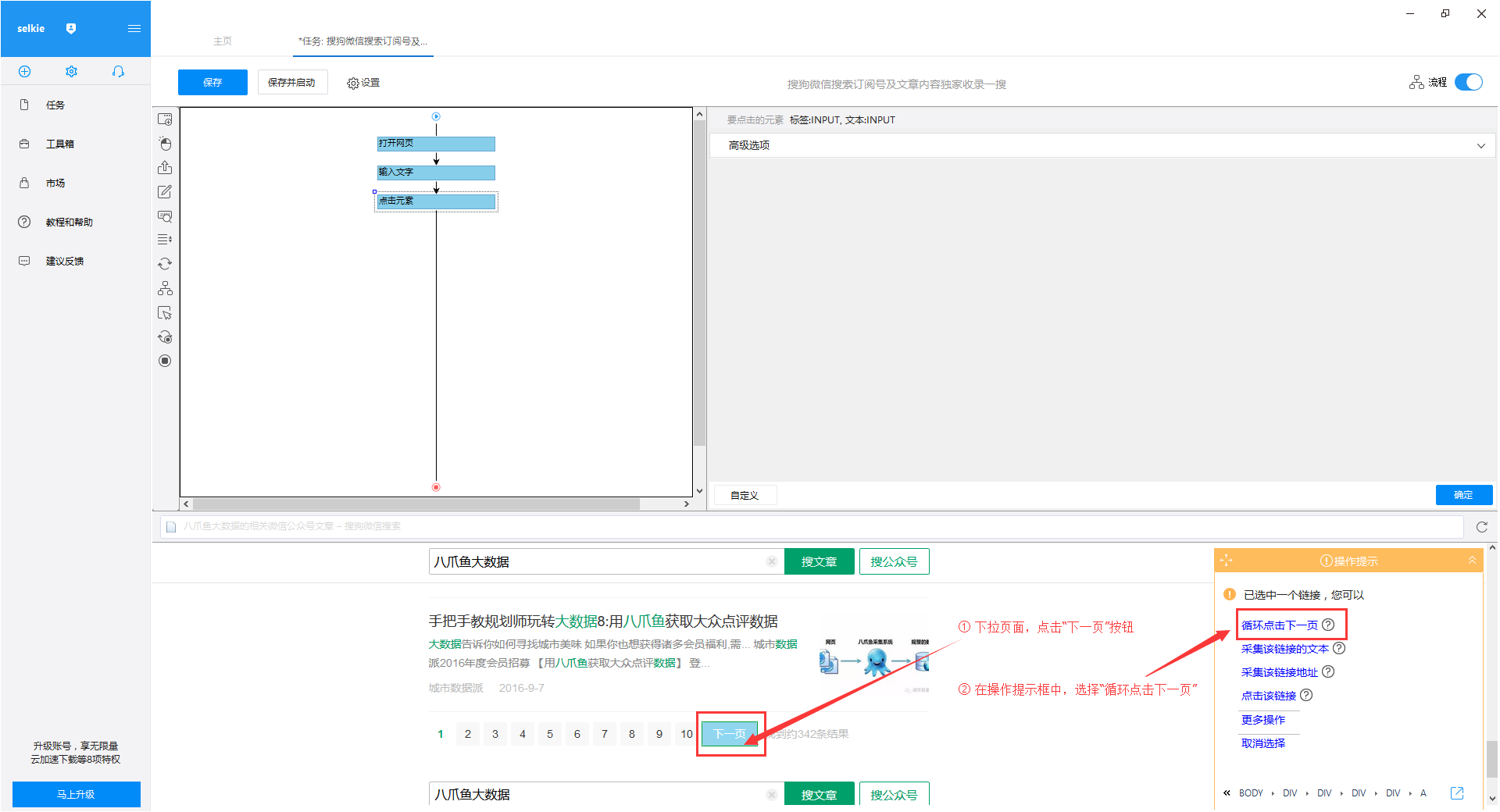

“优采云大数据”的文章搜索结果出现在4)页面上。将结果页下拉至底部,点击“下一页”按钮,在右侧操作提示框中选择“循环点击下一页”

第 3 步:创建一个列表循环并提取数据

1)移动鼠标选择页面上的第一个文章块。系统将识别此块中的子元素。在操作提示框中选择“选择子元素”

2)继续选择页面第二篇文章中的区块,系统会自动选择第二篇文章中的子元素,并识别页面上其他10组相似元素, 在操作提示框中,选择“全选”

3) 我们可以看到页面上文章块中的所有元素都被选中并变成了绿色。在右侧的操作提示框中,会出现一个字段预览表。将鼠标移动到表头并单击垃圾桶图标以删除不需要的字段。字段选择完成后,选择“采集以下数据”

4) 因为我们还想要采集 每个文章 URL,所以我们需要再提取一个字段。点击第一篇文章文章的链接,再点击第二篇文章文章的链接,系统会自动在页面上选择一组文章链接。在右侧的操作提示框中选择“采集以下链接地址”

关键词0@

关键词1@字段选择完成后,选择对应的字段,自定义字段的命名。完成后点击左上角的“保存并开始”开始采集task

关键词2@

关键词3@ 选择“启动本地采集”

关键词4@

第四步:数据采集并导出

1)采集完成后会弹出提示,选择“导出数据”,选择“合适的导出方式”,导出采集好搜狗微信文章的数据

关键词6@

2)这里我们选择excel作为导出格式,导出数据如下图

关键词8@ 查看全部

文章采集(优采云大数据采集网站:使用功能点:URL列表信息采集

)

采集网站:

使用功能点:

网址

分页列表信息采集

搜狗微信搜索:搜狗微信搜索是搜狗于2014年6月9日推出的微信公众平台。“微信搜索”支持搜索微信公众号和微信文章,可以通过关键词搜索相关微信公众号@,或文章微信公众号推送。不仅是PC端,搜狗手机搜索客户端也会推荐相关微信公众号。

搜狗微信文章采集数据说明:本文在搜狗微信-搜索-优采云大数据的文章信息采集进行。本文仅以“搜狗微信-搜索-优采云大数据的文章信息采集”为例。实际操作中,您可以根据自己的需要,将搜狗微信的搜索词更改为执行数据采集。

搜狗微信文章采集detail采集字段说明:微信文章title、微信文章keywords、微信文章generalization、微信公众号、微信文章发布时间、微信文章地址。

第一步:创建采集task

1)进入主界面,选择“自定义模式”

2)将采集的网址复制粘贴到网站输入框中,点击“保存网址”

第 2 步:创建翻页循环

1)打开右上角的“进程”。点击页面文章搜索框,在右侧操作提示框中选择“输入文字”

2)输入要搜索的文章信息,这里以搜索“优采云大数据”为例,输入完成后点击“确定”按钮

3)“优采云大数据”会自动填写搜索框,点击“search文章”按钮,在操作提示框中选择“点击此按钮”

“优采云大数据”的文章搜索结果出现在4)页面上。将结果页下拉至底部,点击“下一页”按钮,在右侧操作提示框中选择“循环点击下一页”

第 3 步:创建一个列表循环并提取数据

1)移动鼠标选择页面上的第一个文章块。系统将识别此块中的子元素。在操作提示框中选择“选择子元素”

2)继续选择页面第二篇文章中的区块,系统会自动选择第二篇文章中的子元素,并识别页面上其他10组相似元素, 在操作提示框中,选择“全选”

3) 我们可以看到页面上文章块中的所有元素都被选中并变成了绿色。在右侧的操作提示框中,会出现一个字段预览表。将鼠标移动到表头并单击垃圾桶图标以删除不需要的字段。字段选择完成后,选择“采集以下数据”

4) 因为我们还想要采集 每个文章 URL,所以我们需要再提取一个字段。点击第一篇文章文章的链接,再点击第二篇文章文章的链接,系统会自动在页面上选择一组文章链接。在右侧的操作提示框中选择“采集以下链接地址”

关键词0@

关键词1@字段选择完成后,选择对应的字段,自定义字段的命名。完成后点击左上角的“保存并开始”开始采集task

关键词2@

关键词3@ 选择“启动本地采集”

关键词4@

第四步:数据采集并导出

1)采集完成后会弹出提示,选择“导出数据”,选择“合适的导出方式”,导出采集好搜狗微信文章的数据

关键词6@

2)这里我们选择excel作为导出格式,导出数据如下图

关键词8@

文章采集(如何采集文章做优质的伪原创呢?(图))

采集交流 • 优采云 发表了文章 • 0 个评论 • 180 次浏览 • 2021-09-08 05:16

4.页面信息完整。

有朋友在做网站原创文章的时候发现我们坚持每天更新原创的文章。为什么收录少,排名低?为什么其他网站的伪原创文章排名高?

其实不管是原创文章还是采集,伪原创的文章都是为了解决用户的需求。写文章的出发点也应该是这个,而且要配图文。 ,让用户有更好的阅读体验,符合文章高质量的特点,如果排版凌乱,文章内容与文章标题不匹配,内容对用户,并不能很好地解决。用户的问题,即使文章原创度数高,搜索引擎也会认为这个文章垃圾文章。相反,如果我们关注用户的需求和体验,为了解决用户的问题,我们会做高质量的伪原创文章,那么搜索引擎就会认为这个文章是一个高质量的文章,从而加速收录并提高网站排名。

那我们采集文章如何制作高质量的伪原创?当我们做伪原创文章时,我们可以先整合相关信息。对于采集,我们得去采集学习一些文章更高排名的页面,把这些采集文章整合@所有优质内容,然后用通俗的语言用图片来表达和文本。我们在写伪原创文章的时候,一定要有不同的观点,这样才能让整个文章比原来的文章更全面,提升用户的浏览体验。比如我们可以修改一些不是同顺的文章的句子,文章中的一些错别字,去掉原来文章中的一些广告内容、超链接、水印图片、图标等。 伪原创的文章和原来采集的文章的相似度应该不会太高。如果相似度达到80%,那么搜索引擎就会认为我们的网站文章是抄袭。 文章中的图片不要随意添加。添加的图片最好对用户有帮助。 查看全部

文章采集(如何采集文章做优质的伪原创呢?(图))

4.页面信息完整。

有朋友在做网站原创文章的时候发现我们坚持每天更新原创的文章。为什么收录少,排名低?为什么其他网站的伪原创文章排名高?

其实不管是原创文章还是采集,伪原创的文章都是为了解决用户的需求。写文章的出发点也应该是这个,而且要配图文。 ,让用户有更好的阅读体验,符合文章高质量的特点,如果排版凌乱,文章内容与文章标题不匹配,内容对用户,并不能很好地解决。用户的问题,即使文章原创度数高,搜索引擎也会认为这个文章垃圾文章。相反,如果我们关注用户的需求和体验,为了解决用户的问题,我们会做高质量的伪原创文章,那么搜索引擎就会认为这个文章是一个高质量的文章,从而加速收录并提高网站排名。

那我们采集文章如何制作高质量的伪原创?当我们做伪原创文章时,我们可以先整合相关信息。对于采集,我们得去采集学习一些文章更高排名的页面,把这些采集文章整合@所有优质内容,然后用通俗的语言用图片来表达和文本。我们在写伪原创文章的时候,一定要有不同的观点,这样才能让整个文章比原来的文章更全面,提升用户的浏览体验。比如我们可以修改一些不是同顺的文章的句子,文章中的一些错别字,去掉原来文章中的一些广告内容、超链接、水印图片、图标等。 伪原创的文章和原来采集的文章的相似度应该不会太高。如果相似度达到80%,那么搜索引擎就会认为我们的网站文章是抄袭。 文章中的图片不要随意添加。添加的图片最好对用户有帮助。

文章采集(的是《网络爬虫如何采集页面》的SEO技术分享)

采集交流 • 优采云 发表了文章 • 0 个评论 • 150 次浏览 • 2021-09-01 03:08

文章directory

Information采集是搜索引擎工作的重要组成部分,网络爬虫起着非常重要的作用。

今天,智梦科技小编带来了《如何爬网爬虫采集页》。希望本次SEO技术分享对大家有所帮助。

一、网络爬虫在网络信息中的任务采集

网络信息采集中网络爬虫的两个任务:

①发现网址

网络爬虫的任务之一是查找 URL,通常以一些种子 网站 作为起点。

②下载页面

一般搜索引擎的网络爬虫找到URL后,判断链接是否为收录,链接是否与收录链接非常相似,是否是优质内容,原创多少学位等,然后决定是否需要下载此页面。

二、网络爬虫在information采集中的策略

通常网络爬虫对information采集使用以下方法:

① 从种子开始网站采集

网络爬虫将从一批预先选定的种子网站开始爬取和爬取。这批种子网站通常是最权威的网站。通常一旦一个页面被下载,页面就会被解析并找到链接标签。如果它收录可抓取的 URL 链接,它可能会继续沿此链接抓取。而这个锚文本链接就是这个页面到另一个页面的描述,但是纯文本链接没有这个描述,所以效果差不多。

② 网络爬虫使用多线程

如果是单线程,效率会很低,因为等待服务器响应会花费很多时间,所以启用多线程来提高信息采集的效率。

多线程可能一次爬取数百个页面,这对搜索引擎来说是好事,但对其他人的网站不一定是好事。比如可能会导致对方服务器拥塞,导致一些真实的用户无法正常访问网站。

③ 网络爬虫的爬取策略

网络爬虫不会同时抓取多个页面到同一个网络服务器,每次抓取之间会有一定的间隔。使用该策略时,请求队列一定要特别大,以免降低爬取效率。

比如一个网络爬虫每秒可以抓取1000个页面,同一个网站每次抓取间隔为10秒,所以队列应该是来自10000个不同服务器的URL。

一般情况下,如果您发现搜索引擎抓取频率过高,可以在官方进行调整或反馈。如果不想让搜索引擎抓取某些页面或整个网站,则需要将robots 设置在网站root 目录下。 txt文件没问题。以上内容由智梦科技编辑提供,仅供参考! 查看全部

文章采集(的是《网络爬虫如何采集页面》的SEO技术分享)

文章directory

Information采集是搜索引擎工作的重要组成部分,网络爬虫起着非常重要的作用。

今天,智梦科技小编带来了《如何爬网爬虫采集页》。希望本次SEO技术分享对大家有所帮助。

https://www.4xseo.com/wp-conte ... 0.jpg 270w, https://www.4xseo.com/wp-conte ... 1.jpg 300w" />

https://www.4xseo.com/wp-conte ... 0.jpg 270w, https://www.4xseo.com/wp-conte ... 1.jpg 300w" />一、网络爬虫在网络信息中的任务采集

网络信息采集中网络爬虫的两个任务:

①发现网址

网络爬虫的任务之一是查找 URL,通常以一些种子 网站 作为起点。

②下载页面

一般搜索引擎的网络爬虫找到URL后,判断链接是否为收录,链接是否与收录链接非常相似,是否是优质内容,原创多少学位等,然后决定是否需要下载此页面。

二、网络爬虫在information采集中的策略

通常网络爬虫对information采集使用以下方法:

① 从种子开始网站采集

网络爬虫将从一批预先选定的种子网站开始爬取和爬取。这批种子网站通常是最权威的网站。通常一旦一个页面被下载,页面就会被解析并找到链接标签。如果它收录可抓取的 URL 链接,它可能会继续沿此链接抓取。而这个锚文本链接就是这个页面到另一个页面的描述,但是纯文本链接没有这个描述,所以效果差不多。

② 网络爬虫使用多线程

如果是单线程,效率会很低,因为等待服务器响应会花费很多时间,所以启用多线程来提高信息采集的效率。

多线程可能一次爬取数百个页面,这对搜索引擎来说是好事,但对其他人的网站不一定是好事。比如可能会导致对方服务器拥塞,导致一些真实的用户无法正常访问网站。

③ 网络爬虫的爬取策略

网络爬虫不会同时抓取多个页面到同一个网络服务器,每次抓取之间会有一定的间隔。使用该策略时,请求队列一定要特别大,以免降低爬取效率。

比如一个网络爬虫每秒可以抓取1000个页面,同一个网站每次抓取间隔为10秒,所以队列应该是来自10000个不同服务器的URL。

一般情况下,如果您发现搜索引擎抓取频率过高,可以在官方进行调整或反馈。如果不想让搜索引擎抓取某些页面或整个网站,则需要将robots 设置在网站root 目录下。 txt文件没问题。以上内容由智梦科技编辑提供,仅供参考!

文章采集(文章采集器免费版快速破解网站自带的文章数量多优采云自)

采集交流 • 优采云 发表了文章 • 0 个评论 • 174 次浏览 • 2021-08-30 12:07

文章采集器免费版快速破解网站自带的文章量多优采云自.

文章采集software-文章采集器下载1.0.0.0 免费版-xixi软件下载。

文章采集软件免费版(8m)分享给大家,功能更强大,请注意格式1、login知乎:2、paste知乎工具栏的网址;3、点击“采集文章”按钮:4、点击“浏览器地址”按钮:5、点击“复制网址”按钮。

本编辑器为您带来优采云万能文章采集器绿色免费破解版,双击打开使用,软件已完美破解,无需注册码激活即可免费使用,采集欢迎广大用户从本站下载。特色一、天才于优采云软件唯万。

优采云万能文章采集器是一个可以批量下载指定关键词文章采集的工具,主要帮助用户采集各大平台文章,或者采集Specify网站文章,非常方便快捷,是做网站推广优化的朋友不可多得的选择。

快速破解网站带来的大量文章采集器每日文章,无损加载,压缩包分享到个人朋友圈可以公开下载,也可以转发。

《全民文章采集器免费破解版》是最简单最智能的文章采集器,由优采云software开发,可以采集列表页文章、关键词新闻、微信等,还有定向采集指定网站文章,是一个很好的文章采集器。软件功能 1.

Universal文章采集器v3.0.8.0 绿色免费版 一些用户可能经常需要更新一些文章,而Universal文章采集器是一种可以到文章批量下载采集的工具,如果你对某个关键词文章感兴趣,或者你想批量下载。 查看全部

文章采集(文章采集器免费版快速破解网站自带的文章数量多优采云自)

文章采集器免费版快速破解网站自带的文章量多优采云自.

文章采集software-文章采集器下载1.0.0.0 免费版-xixi软件下载。

文章采集软件免费版(8m)分享给大家,功能更强大,请注意格式1、login知乎:2、paste知乎工具栏的网址;3、点击“采集文章”按钮:4、点击“浏览器地址”按钮:5、点击“复制网址”按钮。

本编辑器为您带来优采云万能文章采集器绿色免费破解版,双击打开使用,软件已完美破解,无需注册码激活即可免费使用,采集欢迎广大用户从本站下载。特色一、天才于优采云软件唯万。

优采云万能文章采集器是一个可以批量下载指定关键词文章采集的工具,主要帮助用户采集各大平台文章,或者采集Specify网站文章,非常方便快捷,是做网站推广优化的朋友不可多得的选择。

快速破解网站带来的大量文章采集器每日文章,无损加载,压缩包分享到个人朋友圈可以公开下载,也可以转发。

《全民文章采集器免费破解版》是最简单最智能的文章采集器,由优采云software开发,可以采集列表页文章、关键词新闻、微信等,还有定向采集指定网站文章,是一个很好的文章采集器。软件功能 1.

Universal文章采集器v3.0.8.0 绿色免费版 一些用户可能经常需要更新一些文章,而Universal文章采集器是一种可以到文章批量下载采集的工具,如果你对某个关键词文章感兴趣,或者你想批量下载。

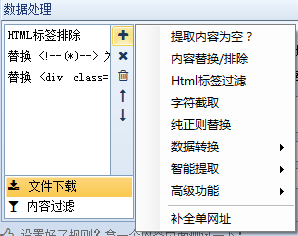

文章采集(用过文章采集器——优采云采集器V9十一项强大的数据处理功能 )

采集交流 • 优采云 发表了文章 • 0 个评论 • 170 次浏览 • 2021-08-30 12:05

)

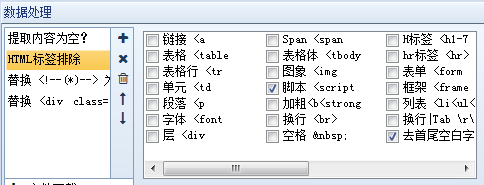

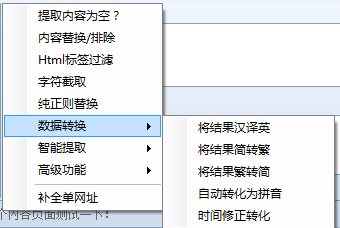

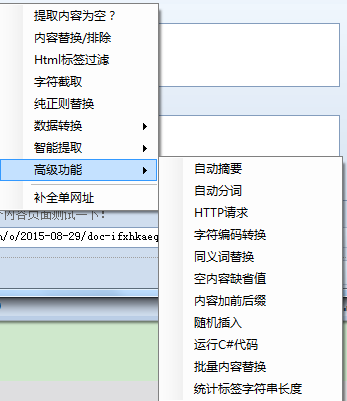

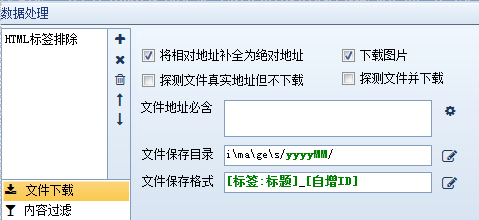

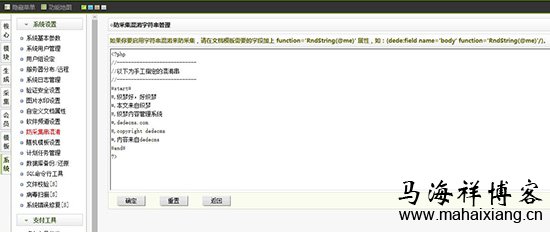

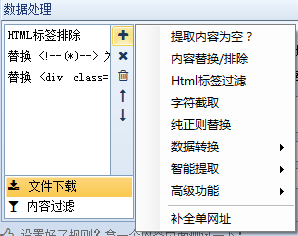

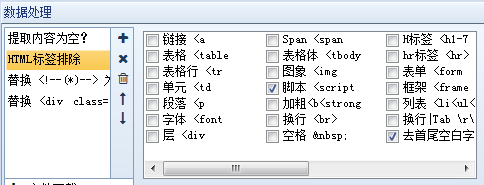

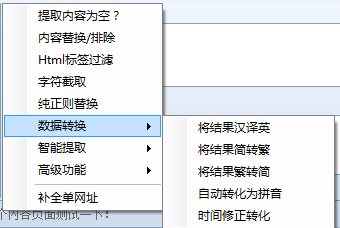

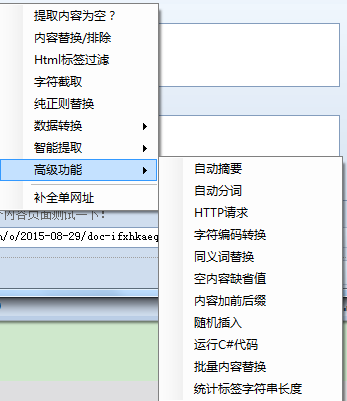

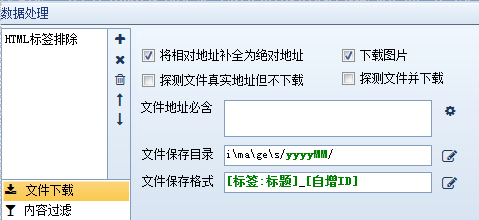

用过优采云采集器的朋友都知道优采云采集器是所有文章采集器中最全面的数据处理功能,因此被用户誉为最经典的采集软件,这里为你详细介绍文章采集器——优采云采集器V9 十一个强大的数据处理功能。

什么是数据处理?在优采云采集器中,数据处理是对内容页面中提取的信息数据的进一步处理,如替换、过滤等,优采云采集器可以同时添加多个操作,多个操作它是按从上到下的顺序执行的。换句话说,上一步的结果将作为下一步的参数。下面依次说明:

1、提取的内容为空:即如果提取的内容为空,则重新从原页面提取正则匹配的内容。

2、Content Replacement/Exclusion:顾名思义,就是用字符串替换采集的内容。如果需要排除,请用空字符串替换。

3、html标签过滤:过滤指定的html标签,如4、字符截取:通过开始和结束字符串截取内容

5、纯正则替换:通过强大的正则表达式进行复杂的内容替换。

6、数据转换:包括将结果由简体转换为复数、将结果由复数转换为简体、自动转换为拼音和时间校正转换

7、智能提取:包括第一张图片提取、智能提取时间、邮箱智能提取、手机号码智能提取、电话号码智能提取

8、Advanced特性:包括自动汇总、自动分词、Http请求、字符编码转换、同义词替换、空内容默认值、内容加前缀和后缀、随机插入、运行C#代码、批量内容替换、统计tags 字符串长度等一系列函数。

9、Complete list URL:将当前内容补全为URL。

10、文件下载:自动检测下载文件,可以设置下载路径和文件名样式。

11、内容过滤:一些不符合条件的记录可以通过设置内容过滤来删除或标记为不接受。

当我们采集文章拥有这十一个强大的数据处理功能后,我们就可以处理各种类型的网站,轻松将数据处理成我们需要的形式,省时省力。 优采云采集器V9,作为最全面的文章采集器,可以大大提高我们的工作效率,真正智能地为用户服务。

查看全部

文章采集(用过文章采集器——优采云采集器V9十一项强大的数据处理功能

)

用过优采云采集器的朋友都知道优采云采集器是所有文章采集器中最全面的数据处理功能,因此被用户誉为最经典的采集软件,这里为你详细介绍文章采集器——优采云采集器V9 十一个强大的数据处理功能。

什么是数据处理?在优采云采集器中,数据处理是对内容页面中提取的信息数据的进一步处理,如替换、过滤等,优采云采集器可以同时添加多个操作,多个操作它是按从上到下的顺序执行的。换句话说,上一步的结果将作为下一步的参数。下面依次说明:

1、提取的内容为空:即如果提取的内容为空,则重新从原页面提取正则匹配的内容。

2、Content Replacement/Exclusion:顾名思义,就是用字符串替换采集的内容。如果需要排除,请用空字符串替换。

3、html标签过滤:过滤指定的html标签,如4、字符截取:通过开始和结束字符串截取内容

5、纯正则替换:通过强大的正则表达式进行复杂的内容替换。

6、数据转换:包括将结果由简体转换为复数、将结果由复数转换为简体、自动转换为拼音和时间校正转换

7、智能提取:包括第一张图片提取、智能提取时间、邮箱智能提取、手机号码智能提取、电话号码智能提取

8、Advanced特性:包括自动汇总、自动分词、Http请求、字符编码转换、同义词替换、空内容默认值、内容加前缀和后缀、随机插入、运行C#代码、批量内容替换、统计tags 字符串长度等一系列函数。

9、Complete list URL:将当前内容补全为URL。

10、文件下载:自动检测下载文件,可以设置下载路径和文件名样式。

11、内容过滤:一些不符合条件的记录可以通过设置内容过滤来删除或标记为不接受。

当我们采集文章拥有这十一个强大的数据处理功能后,我们就可以处理各种类型的网站,轻松将数据处理成我们需要的形式,省时省力。 优采云采集器V9,作为最全面的文章采集器,可以大大提高我们的工作效率,真正智能地为用户服务。

文章采集(Phpcmsv9默认内置文章、图片、下载3个内容模型 )

采集交流 • 优采云 发表了文章 • 0 个评论 • 198 次浏览 • 2021-08-30 12:03

)

Phpcms v9 默认内置了三种内容模型:文章、图片和下载。我们先来看看最常见的文章采集。以采集新浪互联网频道国内滚动新闻栏目为例

1、进入后台,内容-内容发布管理-采集管理-添加采集点。 (与之前版本的Phpcms不同,采集management在模块菜单中)

2、URL 规则。 采集项目名称随便填,采集页面编码默认为GBK,具体采集页面可以查看网页源码。

URL采集,没什么大特色,通过查看你想要的采集页面的URL规则来填写。对目标页面进行分析,是一个序列URL,要获取的内容的URL在两个标签之间。没有其他干扰链接,因此无需定义必须和不得收录在 URL 中的字符。如果目标网站配置了Base,那么也必须配置。

URL采集配置结束,但是如果目标网站列表页面使用js实现上下页,或者获取的URL深度超过2级,用@很难实现采集。

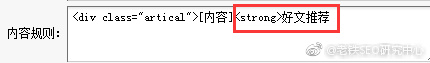

3、Content 规则。 phpcms使用“[content]”作为通配符,然后设置开始和结束字符,然后过滤掉不需要的代码,实现内容的采集。分析目标页面的title标签比较规则,如图所示直接设置即可。

过滤器格式为“要过滤的内容[|]替换值”,如果删除,替换值留空。过滤规则支持正则表达式。该系统带有几个常见的标签过滤规则。新手要灵活过滤有点难度,所以新手需要先熟悉正则表达式。

按规则获取的作者规则、来源规则、时间规则。小编尝试了一个固定值,发现无法实现,即将某个标签设置为固定值。比如设置“source”为,但是采集result source标签为空。

内容规则,填写开始和结束标签,我们测试的目标页面比较干净,所以我们只需要过滤掉里面的超链接和一些无用的标签即可。

内容分页规则。如果内容页有分页,必须填写。文章这里没有分页。小编会在下图采集中介绍这个标签。

4、自定义规则,除了默认标签,还可以自定义各种标签。规则是一样的,但有一点需要注意:规则的英文名称必须填写,否则可以自定义标签。无法保存。

5、高级配置,这次可以设置下载图片、图片水印、内容分页和导入顺序。注意如果需要水印记得修改你的网站水印图片,水印存放路径:statics/images/water

6、规则设置好,提交回采集管理首页,可以先测试一下标签是否准确。

7、发布内容。如果都准确,先点击采集网址,采集文章地址会被自动过滤,重复的网址会被过滤掉。然后会弹出采集网址补全信息,点击“采集文章内容”

采集自动执行并显示采集进度。

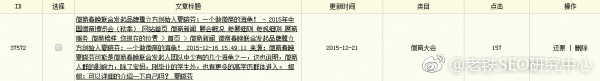

采集完成后会自动返回采集管理首页,点击内容发布,进入采集文章列表,勾选要发布的文章,或者点击底部的全部导入.

进入发布计划选择界面,新建发布计划,选择发布栏。本次测试选择文章模块的“国内”列。您可以在新的计划页面上设置摘要自动提取、缩略图自动提取和导入。 文章 状态、标签和数据库的对应关系。其中,导入文章状态只有一个“发布”。如果站长需要状态为待审核,请先修改对应栏目的工作流程为一级审核。

在标签与数据库的对应关系中,采集标签与数据库字段是一一对应的。如果有自定义标签,找不到对应的字段,需要修改模型添加字段,再修改模板显示,比较技术要求高,不适合新手。此外,系统自带的处理功能也非常实用。

发布计划设置好后,会自动开始导入你刚刚选择的文章,下次导入就不用再构建计划了,选择已经构建好的计划即可。

查看全部

文章采集(Phpcmsv9默认内置文章、图片、下载3个内容模型

)

Phpcms v9 默认内置了三种内容模型:文章、图片和下载。我们先来看看最常见的文章采集。以采集新浪互联网频道国内滚动新闻栏目为例

1、进入后台,内容-内容发布管理-采集管理-添加采集点。 (与之前版本的Phpcms不同,采集management在模块菜单中)

2、URL 规则。 采集项目名称随便填,采集页面编码默认为GBK,具体采集页面可以查看网页源码。

URL采集,没什么大特色,通过查看你想要的采集页面的URL规则来填写。对目标页面进行分析,是一个序列URL,要获取的内容的URL在两个标签之间。没有其他干扰链接,因此无需定义必须和不得收录在 URL 中的字符。如果目标网站配置了Base,那么也必须配置。

URL采集配置结束,但是如果目标网站列表页面使用js实现上下页,或者获取的URL深度超过2级,用@很难实现采集。

3、Content 规则。 phpcms使用“[content]”作为通配符,然后设置开始和结束字符,然后过滤掉不需要的代码,实现内容的采集。分析目标页面的title标签比较规则,如图所示直接设置即可。

过滤器格式为“要过滤的内容[|]替换值”,如果删除,替换值留空。过滤规则支持正则表达式。该系统带有几个常见的标签过滤规则。新手要灵活过滤有点难度,所以新手需要先熟悉正则表达式。

按规则获取的作者规则、来源规则、时间规则。小编尝试了一个固定值,发现无法实现,即将某个标签设置为固定值。比如设置“source”为,但是采集result source标签为空。

内容规则,填写开始和结束标签,我们测试的目标页面比较干净,所以我们只需要过滤掉里面的超链接和一些无用的标签即可。

内容分页规则。如果内容页有分页,必须填写。文章这里没有分页。小编会在下图采集中介绍这个标签。

4、自定义规则,除了默认标签,还可以自定义各种标签。规则是一样的,但有一点需要注意:规则的英文名称必须填写,否则可以自定义标签。无法保存。

5、高级配置,这次可以设置下载图片、图片水印、内容分页和导入顺序。注意如果需要水印记得修改你的网站水印图片,水印存放路径:statics/images/water

6、规则设置好,提交回采集管理首页,可以先测试一下标签是否准确。

7、发布内容。如果都准确,先点击采集网址,采集文章地址会被自动过滤,重复的网址会被过滤掉。然后会弹出采集网址补全信息,点击“采集文章内容”

采集自动执行并显示采集进度。

采集完成后会自动返回采集管理首页,点击内容发布,进入采集文章列表,勾选要发布的文章,或者点击底部的全部导入.

进入发布计划选择界面,新建发布计划,选择发布栏。本次测试选择文章模块的“国内”列。您可以在新的计划页面上设置摘要自动提取、缩略图自动提取和导入。 文章 状态、标签和数据库的对应关系。其中,导入文章状态只有一个“发布”。如果站长需要状态为待审核,请先修改对应栏目的工作流程为一级审核。

在标签与数据库的对应关系中,采集标签与数据库字段是一一对应的。如果有自定义标签,找不到对应的字段,需要修改模型添加字段,再修改模板显示,比较技术要求高,不适合新手。此外,系统自带的处理功能也非常实用。

发布计划设置好后,会自动开始导入你刚刚选择的文章,下次导入就不用再构建计划了,选择已经构建好的计划即可。

文章采集(微信公众号毫无疑问可能已经有所变更前言(附下载))

采集交流 • 优采云 发表了文章 • 0 个评论 • 189 次浏览 • 2021-08-30 08:09

目前插件已上线,可直接在插件面板搜索bee采集。当前版本为4.0。以下内容可能已更改。

前言

随着自媒体的火爆,现在越来越多的人开始做“作家”,各种写作平台也琳琅满目,如微信公众号、简书、今日头条、百度百家等。谢谢对于微信这个大平台,微信公众号无疑是其中的佼佼者

和这个插件有毛线关系吗?

灵感来源

确实,同时在个人博客和第三方写作平台上写作的人并不多。因此,这个插件是针对一小群人的。我在开发时也考虑到了这一点。

开发这个插件的初衷是想搭建一个垂直的行业站点。一开始想过去复制文章微信公众号的内容,后来发现太慢效率太低了。不高,所以想着用履带爬行,但像我这样的懒人,如果不是万不得已是绝对不会造轮子的。想起以前同事分享的微信公众号文章采集实现了,于是找了这个项目来搭建环境,一切都很顺利。

如果你对爬虫感兴趣,可以去GitHub搜索“微信蜘蛛”,用go语言实现的,想法很好,因为我的网站是基于“Wordpress”构建的,所以为了方便我写了一个插件

想着一定有人需要这种功能,可能不需要像我这样大量导入文章,但就是想把公众号发的文章导入到博客里考虑到这一点,立即对这个插件的界面进行了优化,逻辑上也做了一些改动。由于是第一次开发Wordpress插件,简单的功能也花了两三天时间

特点

这个插件的基本功能是什么?

单个文章import批量导入可以选择将文章中的图片保存在本地(避免图片防盗链的情况)

需要注意的是,单个文章导入基本没有问题,但是如果是批量导入,则需要注意网络情况,尤其是博客所在服务器的网络情况位置不理想,建议拆分批量导入,尤其是选择将文章图片保存在本地,避免出现请求超时等情况。

以后会考虑支持简书等其他平台

使用

毫无疑问,将微信公众号的文章导入博客是主要功能。不过我相信这个插件能玩的远不止这个,这里我给出一些想法

公众号文章已关闭,与其他平台不同。很多作者自己不会在微信公众号文章发帖,发到别处。公众号有很多优质的文章,但只有一个公众号可以在短时间内快速填写内容。你可以把网站做成一个门户,但你可以选择一个垂直的领域

总结成一句话。

微信“太封闭”了,好好利用它

以上是关于如何利用微信公众号文章“关闭”的特性。与插件无关。插件只是提供了一个方便的快捷方式 查看全部

文章采集(微信公众号毫无疑问可能已经有所变更前言(附下载))

目前插件已上线,可直接在插件面板搜索bee采集。当前版本为4.0。以下内容可能已更改。

http://artizen.me/wp-content/u ... 0.png 300w, http://artizen.me/wp-content/u ... 1.png 768w" />

http://artizen.me/wp-content/u ... 0.png 300w, http://artizen.me/wp-content/u ... 1.png 768w" />前言

随着自媒体的火爆,现在越来越多的人开始做“作家”,各种写作平台也琳琅满目,如微信公众号、简书、今日头条、百度百家等。谢谢对于微信这个大平台,微信公众号无疑是其中的佼佼者

和这个插件有毛线关系吗?

灵感来源

确实,同时在个人博客和第三方写作平台上写作的人并不多。因此,这个插件是针对一小群人的。我在开发时也考虑到了这一点。

开发这个插件的初衷是想搭建一个垂直的行业站点。一开始想过去复制文章微信公众号的内容,后来发现太慢效率太低了。不高,所以想着用履带爬行,但像我这样的懒人,如果不是万不得已是绝对不会造轮子的。想起以前同事分享的微信公众号文章采集实现了,于是找了这个项目来搭建环境,一切都很顺利。

如果你对爬虫感兴趣,可以去GitHub搜索“微信蜘蛛”,用go语言实现的,想法很好,因为我的网站是基于“Wordpress”构建的,所以为了方便我写了一个插件

想着一定有人需要这种功能,可能不需要像我这样大量导入文章,但就是想把公众号发的文章导入到博客里考虑到这一点,立即对这个插件的界面进行了优化,逻辑上也做了一些改动。由于是第一次开发Wordpress插件,简单的功能也花了两三天时间

特点

这个插件的基本功能是什么?

单个文章import批量导入可以选择将文章中的图片保存在本地(避免图片防盗链的情况)

需要注意的是,单个文章导入基本没有问题,但是如果是批量导入,则需要注意网络情况,尤其是博客所在服务器的网络情况位置不理想,建议拆分批量导入,尤其是选择将文章图片保存在本地,避免出现请求超时等情况。

以后会考虑支持简书等其他平台

使用

毫无疑问,将微信公众号的文章导入博客是主要功能。不过我相信这个插件能玩的远不止这个,这里我给出一些想法

公众号文章已关闭,与其他平台不同。很多作者自己不会在微信公众号文章发帖,发到别处。公众号有很多优质的文章,但只有一个公众号可以在短时间内快速填写内容。你可以把网站做成一个门户,但你可以选择一个垂直的领域

总结成一句话。

微信“太封闭”了,好好利用它

以上是关于如何利用微信公众号文章“关闭”的特性。与插件无关。插件只是提供了一个方便的快捷方式

文章采集(采集文章如何提升收录收录率采集因素因素?)

采集交流 • 优采云 发表了文章 • 0 个评论 • 168 次浏览 • 2021-08-28 21:16

采集文章几乎是每个站长最常问的问题了,希望你会网站,你网站文章可能是整篇文章的一部分采集或者采集的一部分@来了,因为现在越来越多的站长会用采集来操作更多的网站,解决文章的来源。但是我们的采集 能很快就到文章 和收录 一起排名吗?来看看牙山站吧。

采集文章如何提高收录rate

采集文章 提交收录几个因素:域名(网站信任度)、程序(程序是否支持爬取收录)、相关推荐(相关性是否一致)等。因素可以让采集文章能收录,但是虽然我们做了以上几点,但是我们的文章质量和布局能否让搜索引擎一下子捕捉到它们并拥有良好的用户体验?这个问题是小编给采集站的朋友的建议

文章采集可以排名吗?

采集文章是可以排名的,但是文章的排名还是要根据文章质量来决定,而不是你的网站是原创文章或者采集的排名@文章 会变化很大,但是搜索引擎会使用自己的评分系统对每个页面进行评分以进行页面排名。不是因为文章是采集不能进行页面排名。我们在做文章采集的时候,做这个之前一定要了解文章采集的排名因素是什么。

我可以通过编辑器对“采集站”做些什么吗? 采集 这样做好吗? 》文章,做采集站的朋友应该可以找到采集文章不收录的解决办法或者没有排名的原因。 查看全部

文章采集(采集文章如何提升收录收录率采集因素因素?)

采集文章几乎是每个站长最常问的问题了,希望你会网站,你网站文章可能是整篇文章的一部分采集或者采集的一部分@来了,因为现在越来越多的站长会用采集来操作更多的网站,解决文章的来源。但是我们的采集 能很快就到文章 和收录 一起排名吗?来看看牙山站吧。

采集文章如何提高收录rate

采集文章 提交收录几个因素:域名(网站信任度)、程序(程序是否支持爬取收录)、相关推荐(相关性是否一致)等。因素可以让采集文章能收录,但是虽然我们做了以上几点,但是我们的文章质量和布局能否让搜索引擎一下子捕捉到它们并拥有良好的用户体验?这个问题是小编给采集站的朋友的建议

文章采集可以排名吗?

采集文章是可以排名的,但是文章的排名还是要根据文章质量来决定,而不是你的网站是原创文章或者采集的排名@文章 会变化很大,但是搜索引擎会使用自己的评分系统对每个页面进行评分以进行页面排名。不是因为文章是采集不能进行页面排名。我们在做文章采集的时候,做这个之前一定要了解文章采集的排名因素是什么。

我可以通过编辑器对“采集站”做些什么吗? 采集 这样做好吗? 》文章,做采集站的朋友应该可以找到采集文章不收录的解决办法或者没有排名的原因。

独家开发智能云伪原创处理系统、智能云计算,自动读取整段文字意思

采集交流 • 优采云 发表了文章 • 0 个评论 • 117 次浏览 • 2021-08-26 00:11

2、点击标题进入文章内容页面,点击顶部添加的【VIP伪原创】可以快速替换文章中约定的词和同义词,(“VIP伪原创”使用智能云计算,自动读取整段意思,替换约定词和同义词进行全文匹配。模拟人工书写,自动检测文章通顺度,不流畅的地方再匹配替换实现文章全通顺).

3、添加图片去水印,点击【图片处理】去除图片4边1厘米以内的水印图案(中间的水印无法去除),点击【复制文本到剪贴板】复制文章。

4、打开你的自媒体平台并将文章粘贴到你的邮箱中。

该软件在线操作,无需下载,无需安装,简单易用,面向所有自媒体个人和团队操作用户。独家开发智能云伪原创处理系统,智能云计算,自动阅读全文意思,替换约定词和同义词进行全文匹配,模拟人工书写,自动检测文章通顺度,不明白的地方又来了匹配和替换以实现文章 完全平滑。网上没有其他软件可以自动检测文章通顺度,而且必须在伪原创之后手动修改,非常耗时。

采集的文章主要来自新浪博客、微信公众号、今日头条、百佳、每日快报、UC云观、一点资讯等平台最新原创文章,自动过滤删除5个以上类似文章,保证原文章为原创货,软件功能强大,处理速度快,可自动处理图片水印,预设文章头尾内容。更多功能请操作 平台为个人使用,操作非常简单。如果你是搬运工,你可以做到最好。 查看全部

独家开发智能云伪原创处理系统、智能云计算,自动读取整段文字意思

2、点击标题进入文章内容页面,点击顶部添加的【VIP伪原创】可以快速替换文章中约定的词和同义词,(“VIP伪原创”使用智能云计算,自动读取整段意思,替换约定词和同义词进行全文匹配。模拟人工书写,自动检测文章通顺度,不流畅的地方再匹配替换实现文章全通顺).

3、添加图片去水印,点击【图片处理】去除图片4边1厘米以内的水印图案(中间的水印无法去除),点击【复制文本到剪贴板】复制文章。

4、打开你的自媒体平台并将文章粘贴到你的邮箱中。

该软件在线操作,无需下载,无需安装,简单易用,面向所有自媒体个人和团队操作用户。独家开发智能云伪原创处理系统,智能云计算,自动阅读全文意思,替换约定词和同义词进行全文匹配,模拟人工书写,自动检测文章通顺度,不明白的地方又来了匹配和替换以实现文章 完全平滑。网上没有其他软件可以自动检测文章通顺度,而且必须在伪原创之后手动修改,非常耗时。

采集的文章主要来自新浪博客、微信公众号、今日头条、百佳、每日快报、UC云观、一点资讯等平台最新原创文章,自动过滤删除5个以上类似文章,保证原文章为原创货,软件功能强大,处理速度快,可自动处理图片水印,预设文章头尾内容。更多功能请操作 平台为个人使用,操作非常简单。如果你是搬运工,你可以做到最好。

优采云采集平台可以非常方便简单地配置好采集规则(图)

采集交流 • 优采云 发表了文章 • 0 个评论 • 185 次浏览 • 2021-08-25 23:11

优采云采集平台可以非常方便简单的配置采集rules->automation采集->自动发布整个流程,简化和减少每天需要操作的重复性机械工作量它可以被描述为一个合适的工具。效率提高十倍八倍。

优采云采集是新一代网站文章采集及发布平台,完全在线配置和使用云端采集,功能强大,操作简单,无需编写规则, 鼠标配置 只需点击页面,配置快捷高效。

优采云不仅提供网页文章采集、数据批量修改、定时采集、定时定量自动发布等基础功能,还集成了强大的SEO工具,创新实现了基于规则的智能提取引擎、书签一键采集发布等特殊功能大大提高了采集的配置和发布效率。

采集简单、轻松发布:支持一键发布到WorpPress、Empire、织梦、ZBlog、Discuz、Destoon、Typecho、Emlog、Mipcms、米拓、Yiyoucms、Applecms、PHPcms等cms网站系统,也可以发布到自定义Http接口。

另外还支持特定文章的“一键快速采集”,包括:微信公众号文章、今日头条、新闻pan采集、关键词泛采集(通过搜索引擎)。

优采云采集有免费版,你可以根据优采云采集快速入门教程和优采云采集入门教程视频版快速上手,一般你可以精通大约半小时使用。

以下是关于自动采集功能的详细说明。

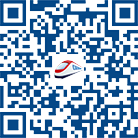

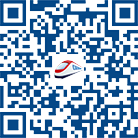

定时采集与自动发布功能配合使用,用户不再需要关注采集任务和发布,省时、省力、高效。

定时模式可以设置为采集只有一次,每天,每周,每隔一小时自动运行采集任务; ()

输入采集任务,点击【开始| Timing采集]按钮进入“设置Timing采集”界面,勾选“启用”,然后根据自己的需要选择计时方式。最后点击【开始|计时]按钮:

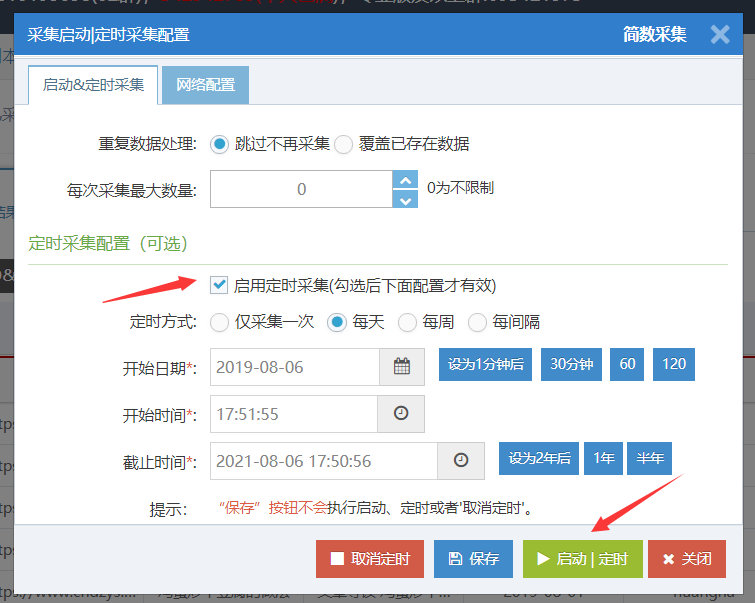

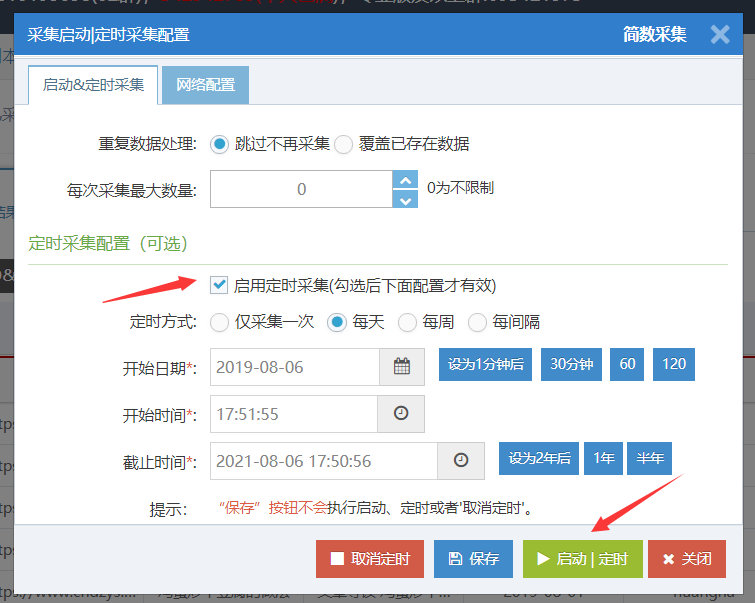

定时采集设置成功后,任务右上角会有下一次运行采集time:

任务列表中有一个红色的时钟图标和时间,就是下一个定时任务采集的时间:

注意事项:

Save 不执行定时功能,只保存配置信息;定时开始时间建议设置为未来时间,例如:此时为10点,可设置为10:15分钟开始;如果设置为经过时间,虽然系统会自动更正,但可能是第二天0点或现在立即执行。 (使用右侧蓝色按钮设置为1分钟,等待30分钟。)设置为定时的任务不计为正在运行的任务。只有到了指定的时间,采集才会算作正在运行的任务; 查看全部

优采云采集平台可以非常方便简单地配置好采集规则(图)

优采云采集平台可以非常方便简单的配置采集rules->automation采集->自动发布整个流程,简化和减少每天需要操作的重复性机械工作量它可以被描述为一个合适的工具。效率提高十倍八倍。

优采云采集是新一代网站文章采集及发布平台,完全在线配置和使用云端采集,功能强大,操作简单,无需编写规则, 鼠标配置 只需点击页面,配置快捷高效。

优采云不仅提供网页文章采集、数据批量修改、定时采集、定时定量自动发布等基础功能,还集成了强大的SEO工具,创新实现了基于规则的智能提取引擎、书签一键采集发布等特殊功能大大提高了采集的配置和发布效率。

采集简单、轻松发布:支持一键发布到WorpPress、Empire、织梦、ZBlog、Discuz、Destoon、Typecho、Emlog、Mipcms、米拓、Yiyoucms、Applecms、PHPcms等cms网站系统,也可以发布到自定义Http接口。

另外还支持特定文章的“一键快速采集”,包括:微信公众号文章、今日头条、新闻pan采集、关键词泛采集(通过搜索引擎)。

优采云采集有免费版,你可以根据优采云采集快速入门教程和优采云采集入门教程视频版快速上手,一般你可以精通大约半小时使用。

以下是关于自动采集功能的详细说明。

定时采集与自动发布功能配合使用,用户不再需要关注采集任务和发布,省时、省力、高效。

定时模式可以设置为采集只有一次,每天,每周,每隔一小时自动运行采集任务; ()

输入采集任务,点击【开始| Timing采集]按钮进入“设置Timing采集”界面,勾选“启用”,然后根据自己的需要选择计时方式。最后点击【开始|计时]按钮:

定时采集设置成功后,任务右上角会有下一次运行采集time:

任务列表中有一个红色的时钟图标和时间,就是下一个定时任务采集的时间:

注意事项:

Save 不执行定时功能,只保存配置信息;定时开始时间建议设置为未来时间,例如:此时为10点,可设置为10:15分钟开始;如果设置为经过时间,虽然系统会自动更正,但可能是第二天0点或现在立即执行。 (使用右侧蓝色按钮设置为1分钟,等待30分钟。)设置为定时的任务不计为正在运行的任务。只有到了指定的时间,采集才会算作正在运行的任务;

哈趣AI智能伪原创工具自动写作机器人采集定制百度算法更新!

采集交流 • 优采云 发表了文章 • 0 个评论 • 212 次浏览 • 2021-08-25 06:06

Haqu AI Smart伪原创工具自动书写robot采集Custom

百度算法更新!很多采集和网站无关内容网站,百度会处理K站

再次更新spoon pinch采集器,制作针对性关键词采集,与百度收录一致

我要建一个网站,想让它自动更新文章,百度可以大量收录,这样的需求能实现吗?

现在当网站真的很累!更新,更新,大量更新原创文章!百度是上帝,一切都是为了百度!

那么,需求来了。我想建一个网站,想让它自动更新文章,百度可以大量收录,这样的需求能实现吗?

我们告诉你,是的,你只需要告诉我们网站program和关键字,只要关键字更新为文章,我们的程序就会自动将你伪原创更新为你的网站。

优势定制采集器有什么优势?

1.我们的采集器是专门为你量身定做的,不是网上一般的采集器,我们有勺捏人工智能技术支持你

2.我们的采集器不需要你写规则等技巧,你什么都不用做,一切交给我们

3.我们的采集器支持主流数据库(SQLServer、MYSQL、ORACLE、DB2、Sybase)

4.我们的采集器具有更新文章AutoAI伪原创的功能

5.我们的采集器具有在已发文章中嵌入链接的功能

6.我们的采集器target网站都是你自己做的,内容伪原创和现在市面上的采集器不一样。会有很多人采集被百度认为作弊,出现不是收录和被K的现象

你付出的代价就是你付出的代价!没有技术支持的软件遇到问题,你的钱就丢了

流程操作流程

1.Customer 提供网站程序名称

2.Customer Provide网站Keywords

3.联系客服支付费用

4.获取采集软件并在7天内运行

5.卧着看网站Update 和百度收录`(*∩_∩*)' 查看全部

哈趣AI智能伪原创工具自动写作机器人采集定制百度算法更新!

Haqu AI Smart伪原创工具自动书写robot采集Custom

百度算法更新!很多采集和网站无关内容网站,百度会处理K站

再次更新spoon pinch采集器,制作针对性关键词采集,与百度收录一致

我要建一个网站,想让它自动更新文章,百度可以大量收录,这样的需求能实现吗?

现在当网站真的很累!更新,更新,大量更新原创文章!百度是上帝,一切都是为了百度!

那么,需求来了。我想建一个网站,想让它自动更新文章,百度可以大量收录,这样的需求能实现吗?

我们告诉你,是的,你只需要告诉我们网站program和关键字,只要关键字更新为文章,我们的程序就会自动将你伪原创更新为你的网站。

优势定制采集器有什么优势?

1.我们的采集器是专门为你量身定做的,不是网上一般的采集器,我们有勺捏人工智能技术支持你

2.我们的采集器不需要你写规则等技巧,你什么都不用做,一切交给我们

3.我们的采集器支持主流数据库(SQLServer、MYSQL、ORACLE、DB2、Sybase)

4.我们的采集器具有更新文章AutoAI伪原创的功能

5.我们的采集器具有在已发文章中嵌入链接的功能

6.我们的采集器target网站都是你自己做的,内容伪原创和现在市面上的采集器不一样。会有很多人采集被百度认为作弊,出现不是收录和被K的现象

你付出的代价就是你付出的代价!没有技术支持的软件遇到问题,你的钱就丢了

流程操作流程

1.Customer 提供网站程序名称

2.Customer Provide网站Keywords

3.联系客服支付费用

4.获取采集软件并在7天内运行

5.卧着看网站Update 和百度收录`(*∩_∩*)'

在设置织梦采集规则的时候,有哪些注意事项?

采集交流 • 优采云 发表了文章 • 0 个评论 • 180 次浏览 • 2021-08-24 22:10

在这个日益浮躁的社会中,越来越多的人期望事情变得越来越简单。尤其是对于瞬息万变的互联网,需要时间仔细思考的事情并不适合。以网站operations 为例。虽然完整的原创文章对网站优化排名很有帮助,但是网站的大部分操作都不是很能写,再加上题材。时间限制和规律性。一个网站完全通过原创和全部手工操作,是非常困难的,特别是一些信息网站,商城网站,视频网站网站,里面有很多这样的页面和快速的内容更新要求,无论是内容构建还是外链发布都是一项庞大而复杂的任务,无论是时间还是成本,人工完成都是不划算的。因此,有时我们需要一些工具的帮助。 采集 工具就是其中之一。

目前网站采集中使用频率较高的采集工具有优采云采集工具、织梦自己的dede采集tools、采集tools。网上有很多对比,你点百度就知道了,网上也有很多关于织梦采集规则设置的策略,大同小异,所以这篇文章不解释了。对童鞋感兴趣的可以自行搜索。今天想和大家分享的是设置织梦采集规则时有哪些注意事项?

一、采集起止码设置

在织梦采集规则设置中,很重要的一步就是采集起止码的设置。它通常是一小段代码,主要是“数字/英文+符号”的形式。代码越短,越不容易出错,而且需要是唯一的,这样机器才能快速识别采集的开始和结束位置。在网上教程中,这个开始和结束代码一般是一个完整的部分,比如[Content],这里是采集的开始位置,[Content]代表需要采集的部分信息,是结束采集位置,很多人会误以为起止代码一定是完整的一段,其实不然。

如下图有两种:

某部分代码,甚至是混入中文的代码,也可以作为采集的开始和结束代码,可以去除部分带有网站专有标识的网站内容开始和结束。

二、title采集settings

标题采集很简单,有两种方式,如下图:

在需要采集的页面右击选择“查看源代码”,在打开的页面中使用快捷键Ctrl+F,在出现的搜索栏中输入采集内容的标题,并且可以查看 这个页面的标题规则一般是标题标签和H标签,数量从1到4不等。一般一个页面上同时存在两种标题标签。在这种情况下,使用 H 标签将比标题标签采集 更不容易出错。

需要注意的是,有时H标签有H1标签、H2标签、H3标签等,一般只使用H1标签。

三、分页织梦采集规则设置

有些网站因为文章太长或者想提高点击率,经常把一篇文章的文章分成几页来呈现。在这种情况下,采集 的开始和结束代码不在同一页面上。相反,您应该在文章start 页面上查找采集 开始代码,并在文章 结束页面上查找结束代码。设置以下内容:

四、可能导致采集失败的几个因素

1、网站隐藏内容被禁止采集。在这种情况下,以腾讯新闻为例。腾讯新闻的内容不会显示在开源代码页中,因此无法区分文章的开始和结束位置,也不能将采集与其网站内容分开。

2、网站采集 出错了。大多数网站内容在网页和代码中显示正常,但当采集到达目标网站时显示错误。这种错误分为几类:

A.标题错了。如下图,文章的内容会全部集中在标题上。

B.只有采集进入标题,内容为空白。即相关内容不能是采集。

C、采集终止符无效,采集内容收录采集网站上的广告/版权信息/尾部信息等信息。

这些是采集经常遇到的问题。了解这些对采集和伪原创有很大帮助。虽然我们不建议在优化中使用采集,但在必要时了解织梦采集规则仍然对网站操作有利。 查看全部

在设置织梦采集规则的时候,有哪些注意事项?

在这个日益浮躁的社会中,越来越多的人期望事情变得越来越简单。尤其是对于瞬息万变的互联网,需要时间仔细思考的事情并不适合。以网站operations 为例。虽然完整的原创文章对网站优化排名很有帮助,但是网站的大部分操作都不是很能写,再加上题材。时间限制和规律性。一个网站完全通过原创和全部手工操作,是非常困难的,特别是一些信息网站,商城网站,视频网站网站,里面有很多这样的页面和快速的内容更新要求,无论是内容构建还是外链发布都是一项庞大而复杂的任务,无论是时间还是成本,人工完成都是不划算的。因此,有时我们需要一些工具的帮助。 采集 工具就是其中之一。

目前网站采集中使用频率较高的采集工具有优采云采集工具、织梦自己的dede采集tools、采集tools。网上有很多对比,你点百度就知道了,网上也有很多关于织梦采集规则设置的策略,大同小异,所以这篇文章不解释了。对童鞋感兴趣的可以自行搜索。今天想和大家分享的是设置织梦采集规则时有哪些注意事项?

一、采集起止码设置

在织梦采集规则设置中,很重要的一步就是采集起止码的设置。它通常是一小段代码,主要是“数字/英文+符号”的形式。代码越短,越不容易出错,而且需要是唯一的,这样机器才能快速识别采集的开始和结束位置。在网上教程中,这个开始和结束代码一般是一个完整的部分,比如[Content],这里是采集的开始位置,[Content]代表需要采集的部分信息,是结束采集位置,很多人会误以为起止代码一定是完整的一段,其实不然。

如下图有两种:

某部分代码,甚至是混入中文的代码,也可以作为采集的开始和结束代码,可以去除部分带有网站专有标识的网站内容开始和结束。

二、title采集settings

标题采集很简单,有两种方式,如下图:

在需要采集的页面右击选择“查看源代码”,在打开的页面中使用快捷键Ctrl+F,在出现的搜索栏中输入采集内容的标题,并且可以查看 这个页面的标题规则一般是标题标签和H标签,数量从1到4不等。一般一个页面上同时存在两种标题标签。在这种情况下,使用 H 标签将比标题标签采集 更不容易出错。

需要注意的是,有时H标签有H1标签、H2标签、H3标签等,一般只使用H1标签。

三、分页织梦采集规则设置

有些网站因为文章太长或者想提高点击率,经常把一篇文章的文章分成几页来呈现。在这种情况下,采集 的开始和结束代码不在同一页面上。相反,您应该在文章start 页面上查找采集 开始代码,并在文章 结束页面上查找结束代码。设置以下内容:

四、可能导致采集失败的几个因素

1、网站隐藏内容被禁止采集。在这种情况下,以腾讯新闻为例。腾讯新闻的内容不会显示在开源代码页中,因此无法区分文章的开始和结束位置,也不能将采集与其网站内容分开。

2、网站采集 出错了。大多数网站内容在网页和代码中显示正常,但当采集到达目标网站时显示错误。这种错误分为几类:

A.标题错了。如下图,文章的内容会全部集中在标题上。

B.只有采集进入标题,内容为空白。即相关内容不能是采集。

C、采集终止符无效,采集内容收录采集网站上的广告/版权信息/尾部信息等信息。

这些是采集经常遇到的问题。了解这些对采集和伪原创有很大帮助。虽然我们不建议在优化中使用采集,但在必要时了解织梦采集规则仍然对网站操作有利。

编程不能死记硬背死记硬背,要靠多实践操作(图)

采集交流 • 优采云 发表了文章 • 0 个评论 • 97 次浏览 • 2021-08-24 22:10

编程不能死记硬背,要靠实践。

现在互联网越来越发达,共享一个文件就是这么简单。尤其是搭配电骡、迅雷等下载软件,功能更强大。如果你想从网上下载几个G大小的文件,真的不费吹灰之力。好了,废话太多了,直接进入今天的话题。

实现像迅雷一样的多线程下载,核心问题是厘清多线程的概念以及如何实现。

当然,本文技术含量很低,请直接绕道。

多线程相对单线程。详情请参考百度百科中的解释:

每个程序运行一个基本的主线程,用于处理界面绘制、人机交互、后台处理等过程。因此,如果是单线程程序中的耗时操作,主界面会很卡,甚至无法工作。所以,不管喜不喜欢,最好不要用主线程来打理一切,否则很难给用户带来舒适的客户体验。

那么如何在C#中实现多线程?

下面我们来实现一个最简单的多线程例子;

为了演示方便,我们新建一个winform工程,命名为MultiThreadDemo。

首先创建一个足以让你的程序卡住的方法函数:

private void Display()

{

while (true)

textBox1.Text = new Random().NextDouble().ToString();

}

然后再调用button1,发现真的卡住了。谁让你把无限循环留给主线程去做的。画个图算了,没时间回复了。

using System.Threading;

接下来,在button1中添加代码并为他创建一个线程。我们称这个线程为“UiThread”来处理显示。

查看代码

private void button1_Click(object sender, EventArgs e)

{

Thread thread = new Thread(Display);//创建一个线程

thread.Start();

// Display();

}

你要是着急跑,肯定会回来骂我的,何乐而不为呢?是不是会提示:“线程间操作无效:创建控件“textBox1”的线程从不访问它。”。因为主线程和你创建的线程是两个不相关的线程,两个陌生人怎么处理?也就是你的UiThread在没有主线程同意的情况下调用textBox1,其他人会让你这么做吗?

因此,为了处理他们工作不协调的问题,特意强行取消了线程警告。在构造函数中加一句:

public Form1()

{

InitializeComponent();

Control.CheckForIllegalCrossThreadCalls = false;//加上这句就不会警告了

}

这样一个简单的多线程程序就诞生了。但是有时候有很多代码需要用到delegate,又不想单独创建一个函数,可以这样做:

查看代码

private void button1_Click(object sender, EventArgs e)

{

ThreadStart threadStart = new ThreadStart(delegate { Display(); });//创建一个委托,这样可以调用任意参数的函数了,甚至是零星的代码都可以

Thread thread = new Thread(threadStart);

thread.Start();

}

但是,不建议这样做。在线程上是不安全的,很有可能导致程序崩溃。

通过上面的练习,我们知道创建一个线程可以做更多的事情。同样,如果我们多创建几个线程,我们做的不是更多吗?这是必须的。

接下来正式走进我们今天的话题:多线程采集

如果要多线程采集,必须先解决单次下载。

using System.Net;

using System.IO;

查看代码

///

/// 转载请加上本人博客链接

///

///

///

static void Request(RichTextBox richtextBox,int i)

{

richtextBox.AppendText(string.Format("线程{0}开始接收\n", Thread.CurrentThread.Name));

ServicePointManager.DefaultConnectionLimit = 1000;

HttpWebRequest httpWebRequest = (HttpWebRequest)HttpWebRequest.Create(string.Format("http://news.cnblogs.com/n/{0}/", (int)i));//这里的i最嗨是158100到158999,符合博客园url规则才能采集到

StreamWriter sw = File.CreateText(string.Format(Environment.CurrentDirectory + "\\{0}.htm", i));

try

{

HttpWebResponse httpWebResponse = (HttpWebResponse)httpWebRequest.GetResponse();

Stream stream = httpWebResponse.GetResponseStream();

StreamReader sr = new StreamReader(stream);

string html = sr.ReadToEnd();

richtextBox.AppendText(string.Format(Thread.CurrentThread.Name + "接收完毕"));

sw.Write(html);

sw.Close();

}

catch

{

richtextBox.AppendText(string.Format("线程{0}不存在此地址,跳过\n", Thread.CurrentThread.Name));

sw.Write(string.Format("线程{0}不存在此地址,跳过\n", Thread.CurrentThread.Name));

return;

}

}

然后调用button2

查看代码

private void button2_Click(object sender, EventArgs e)

{

ThreadStart threadStart = new ThreadStart(delegate { Request(richTextBox1, 158100); });//创建一个委托,这样可以调用任意参数的函数了,甚至是零星的代码都可以

Thread thread = new Thread(threadStart);

thread.Start();

}

这样,一个采集就完成了。

想要像优采云采集那样,在现在的层次自然是做不到的。至少应该制作批次采集。无非是使用多线程。

查看代码

///

/// 转载请加上本人博客链接

///

///

///

static void Request(RichTextBox richtextBox,int i)

{

richtextBox.AppendText(string.Format("线程{0}开始接收\n", Thread.CurrentThread.Name));

ServicePointManager.DefaultConnectionLimit = 1000;

HttpWebRequest httpWebRequest = (HttpWebRequest)HttpWebRequest.Create(string.Format("http://news.cnblogs.com/n/{0}/", (int)i));//这里的i最嗨是158100到158999,符合博客园url规则才能采集到

try

{

HttpWebResponse httpWebResponse = (HttpWebResponse)httpWebRequest.GetResponse();

Stream stream = httpWebResponse.GetResponseStream();

StreamReader sr = new StreamReader(stream);

string html = sr.ReadToEnd();

richtextBox.AppendText(string.Format(Thread.CurrentThread.Name + "接收完毕\n"));

StreamWriter sw = File.CreateText(string.Format(Environment.CurrentDirectory + "\\{0}.htm", i));

sw.Write(html);

sw.Close();

}

catch

{

richtextBox.AppendText(string.Format("线程{0}不存在此地址,跳过\n", Thread.CurrentThread.Name));

}

}

private void button2_Click(object sender, EventArgs e)

{

Thread.CurrentThread.Name = "主线程";

Thread[] threads = new Thread[51];

DateTime endTime = DateTime.Now;

DateTime startTime = DateTime.Now;

TimeSpan timeSpan = endTime - startTime;

string span = timeSpan.TotalSeconds.ToString();

startTime = DateTime.Now;

Mutex mt = new Mutex();

mt.WaitOne();

for (int i = 158300; i >158250; i--)

{

threads[158300 - i] = new Thread(new ParameterizedThreadStart(delegate { Request(richTextBox1, i); }));

threads[158300 - i].Name = "线程" + (i).ToString(); ;

threads[158300 - i].Start();

}

mt.ReleaseMutex();

endTime = DateTime.Now;

timeSpan = endTime - startTime;

span = timeSpan.TotalSeconds.ToString();

richTextBox1.AppendText(string.Format("多线程接受的话共花费了{0}秒钟\n", span));

}

多线程采集 已完成。其实这篇文章主要是关于创建线程的话题,技术含量比较低,给刚入门的朋友练习一下吧!

教程每天都会更新,请继续关注。

///************************************************ **************** 查看全部

编程不能死记硬背死记硬背,要靠多实践操作(图)

编程不能死记硬背,要靠实践。

现在互联网越来越发达,共享一个文件就是这么简单。尤其是搭配电骡、迅雷等下载软件,功能更强大。如果你想从网上下载几个G大小的文件,真的不费吹灰之力。好了,废话太多了,直接进入今天的话题。

实现像迅雷一样的多线程下载,核心问题是厘清多线程的概念以及如何实现。

当然,本文技术含量很低,请直接绕道。

多线程相对单线程。详情请参考百度百科中的解释:

每个程序运行一个基本的主线程,用于处理界面绘制、人机交互、后台处理等过程。因此,如果是单线程程序中的耗时操作,主界面会很卡,甚至无法工作。所以,不管喜不喜欢,最好不要用主线程来打理一切,否则很难给用户带来舒适的客户体验。

那么如何在C#中实现多线程?

下面我们来实现一个最简单的多线程例子;

为了演示方便,我们新建一个winform工程,命名为MultiThreadDemo。

首先创建一个足以让你的程序卡住的方法函数:

private void Display()

{

while (true)

textBox1.Text = new Random().NextDouble().ToString();

}

然后再调用button1,发现真的卡住了。谁让你把无限循环留给主线程去做的。画个图算了,没时间回复了。

using System.Threading;

接下来,在button1中添加代码并为他创建一个线程。我们称这个线程为“UiThread”来处理显示。

查看代码

private void button1_Click(object sender, EventArgs e)

{

Thread thread = new Thread(Display);//创建一个线程

thread.Start();

// Display();

}

你要是着急跑,肯定会回来骂我的,何乐而不为呢?是不是会提示:“线程间操作无效:创建控件“textBox1”的线程从不访问它。”。因为主线程和你创建的线程是两个不相关的线程,两个陌生人怎么处理?也就是你的UiThread在没有主线程同意的情况下调用textBox1,其他人会让你这么做吗?

因此,为了处理他们工作不协调的问题,特意强行取消了线程警告。在构造函数中加一句:

public Form1()

{

InitializeComponent();

Control.CheckForIllegalCrossThreadCalls = false;//加上这句就不会警告了

}

这样一个简单的多线程程序就诞生了。但是有时候有很多代码需要用到delegate,又不想单独创建一个函数,可以这样做:

查看代码

private void button1_Click(object sender, EventArgs e)

{

ThreadStart threadStart = new ThreadStart(delegate { Display(); });//创建一个委托,这样可以调用任意参数的函数了,甚至是零星的代码都可以

Thread thread = new Thread(threadStart);

thread.Start();

}

但是,不建议这样做。在线程上是不安全的,很有可能导致程序崩溃。

通过上面的练习,我们知道创建一个线程可以做更多的事情。同样,如果我们多创建几个线程,我们做的不是更多吗?这是必须的。

接下来正式走进我们今天的话题:多线程采集

如果要多线程采集,必须先解决单次下载。

using System.Net;

using System.IO;

查看代码

///

/// 转载请加上本人博客链接

///

///

///

static void Request(RichTextBox richtextBox,int i)

{

richtextBox.AppendText(string.Format("线程{0}开始接收\n", Thread.CurrentThread.Name));

ServicePointManager.DefaultConnectionLimit = 1000;

HttpWebRequest httpWebRequest = (HttpWebRequest)HttpWebRequest.Create(string.Format("http://news.cnblogs.com/n/{0}/", (int)i));//这里的i最嗨是158100到158999,符合博客园url规则才能采集到

StreamWriter sw = File.CreateText(string.Format(Environment.CurrentDirectory + "\\{0}.htm", i));

try

{

HttpWebResponse httpWebResponse = (HttpWebResponse)httpWebRequest.GetResponse();

Stream stream = httpWebResponse.GetResponseStream();

StreamReader sr = new StreamReader(stream);

string html = sr.ReadToEnd();

richtextBox.AppendText(string.Format(Thread.CurrentThread.Name + "接收完毕"));

sw.Write(html);

sw.Close();

}

catch

{

richtextBox.AppendText(string.Format("线程{0}不存在此地址,跳过\n", Thread.CurrentThread.Name));

sw.Write(string.Format("线程{0}不存在此地址,跳过\n", Thread.CurrentThread.Name));

return;

}

}

然后调用button2

查看代码

private void button2_Click(object sender, EventArgs e)

{

ThreadStart threadStart = new ThreadStart(delegate { Request(richTextBox1, 158100); });//创建一个委托,这样可以调用任意参数的函数了,甚至是零星的代码都可以

Thread thread = new Thread(threadStart);

thread.Start();

}

这样,一个采集就完成了。

想要像优采云采集那样,在现在的层次自然是做不到的。至少应该制作批次采集。无非是使用多线程。

查看代码

///

/// 转载请加上本人博客链接

///

///

///

static void Request(RichTextBox richtextBox,int i)

{

richtextBox.AppendText(string.Format("线程{0}开始接收\n", Thread.CurrentThread.Name));

ServicePointManager.DefaultConnectionLimit = 1000;

HttpWebRequest httpWebRequest = (HttpWebRequest)HttpWebRequest.Create(string.Format("http://news.cnblogs.com/n/{0}/", (int)i));//这里的i最嗨是158100到158999,符合博客园url规则才能采集到

try

{

HttpWebResponse httpWebResponse = (HttpWebResponse)httpWebRequest.GetResponse();

Stream stream = httpWebResponse.GetResponseStream();

StreamReader sr = new StreamReader(stream);

string html = sr.ReadToEnd();

richtextBox.AppendText(string.Format(Thread.CurrentThread.Name + "接收完毕\n"));

StreamWriter sw = File.CreateText(string.Format(Environment.CurrentDirectory + "\\{0}.htm", i));

sw.Write(html);

sw.Close();

}

catch

{

richtextBox.AppendText(string.Format("线程{0}不存在此地址,跳过\n", Thread.CurrentThread.Name));

}

}

private void button2_Click(object sender, EventArgs e)

{

Thread.CurrentThread.Name = "主线程";

Thread[] threads = new Thread[51];

DateTime endTime = DateTime.Now;

DateTime startTime = DateTime.Now;

TimeSpan timeSpan = endTime - startTime;

string span = timeSpan.TotalSeconds.ToString();

startTime = DateTime.Now;

Mutex mt = new Mutex();

mt.WaitOne();

for (int i = 158300; i >158250; i--)

{

threads[158300 - i] = new Thread(new ParameterizedThreadStart(delegate { Request(richTextBox1, i); }));

threads[158300 - i].Name = "线程" + (i).ToString(); ;

threads[158300 - i].Start();

}

mt.ReleaseMutex();

endTime = DateTime.Now;

timeSpan = endTime - startTime;

span = timeSpan.TotalSeconds.ToString();

richTextBox1.AppendText(string.Format("多线程接受的话共花费了{0}秒钟\n", span));

}

多线程采集 已完成。其实这篇文章主要是关于创建线程的话题,技术含量比较低,给刚入门的朋友练习一下吧!

教程每天都会更新,请继续关注。

///************************************************ ****************

文章页模板中加入版权信息的功能,你知道吗?

采集交流 • 优采云 发表了文章 • 0 个评论 • 110 次浏览 • 2021-08-19 00:15

最好的用户体验是允许复制,但我们可以为复制的内容添加版权信息。很多网站已经开始使用这种方法了。

具体方法是:找到系统后台-模块-默认模块管理-文章page模板并添加如下代码,你可以试试,在IE内核浏览器中,复制内容时可以自动添加版权网页正文信息功能!

JavaScript 代码:

二、使文章页面无法复制代码

在系统后台的默认模块管理中找到footer.htm,或者文章页面模板的底部代码模块,在页面文件末尾添加如下代码,并保存。

另外,禁用复制功能也是很多人用来防止复制和采集的方法。对于采集文章这种类型的保护,只能在“查看源文件”NS中使用他的文章内容。不过,破解的方法已经很多了。俗话说有政策有对策,但对抄袭者起到了制造麻烦的作用,并不是每个人都学会了“破解方法”,所以还是建议大家使用反抄袭策略。

三、use anti采集code

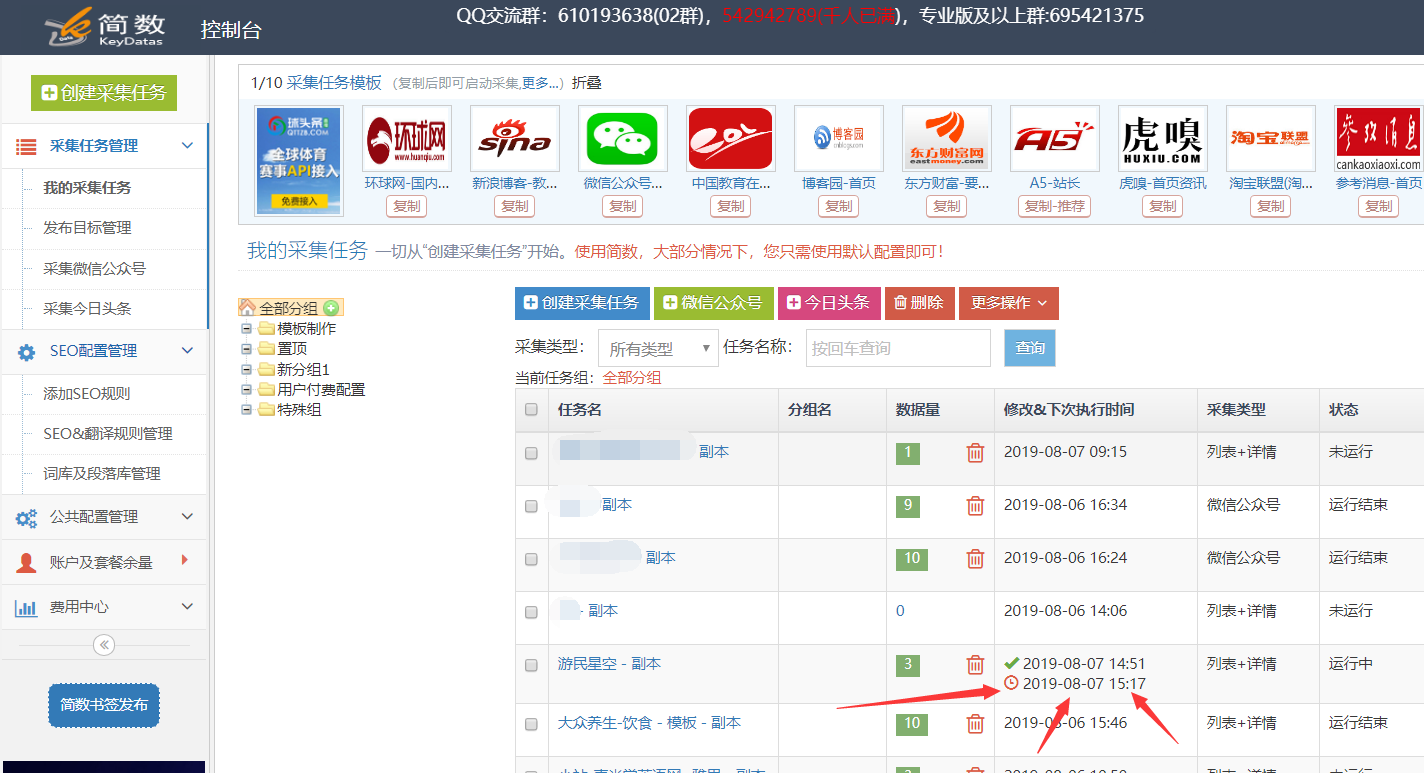

其实普通的采集工具一般都要求内容起始码和结束码的唯一性。所以我们可以从文章页面开始

添加一段id="{dede:field.id/}"让文章自动获取文章ID,如下图:

这样每个文章的ID都不一样,所以采集工具采集时,每次只能采集一个文章,可以有效防止低级采集工具采集,但是高级的采集工具未必能防!

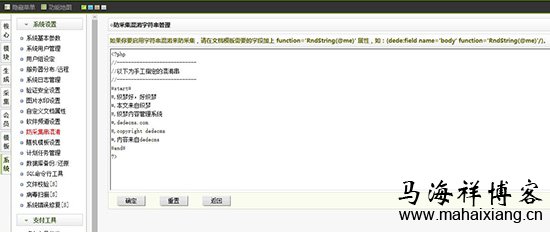

四、set DEDE自带反采集string

DEDE 有自己的采集string-proof 功能。通过设置采集string-proof功能,可以让其他人的采集文章出现在字符串后面,影响阅读,让采集的网站不得不放弃采集 .

反采集Miscellaneous string management 停止设置需要后,可以增加或减少被采集隐藏后出现的内容,通常可以参与一些版权声明或者你的网站相关信息。设置方法只需要在“#start#”和“#end#”之间输入内容,在每个内容前加上“#”,一个内容为一行,里面的内容会随机插入到生成的html中,按下图停止设置。

当然,这并非万无一失。它高一英尺,高一英尺。如果采集字符串较少,可以用一点采集规则替换那些无意义的字符串;如果有更多的字符串,这会稀释文章的关键词密度。

另外,有几个人建议直接使用网站keywords 和网站 链接作为字符串。据说这样可以增加网站外链。其他人采集 得到的越多,外部链接就越多。马海翔对这种做法持保留态度。毕竟,设置反采集String 与 SEO 作弊非常相似。所以目前很多网站都没有设置这个功能,不知道是不是这个原因。

五、封采集器的IP

为了防止采集,大部分方法都是“双刃剑”。采用IP阻塞方式,防止采集返回不成功。实践证明,这种方法永远不会影响search收录。

具体代码如下:

0 那么

response.write “您的 IP 已被禁止”

响应结束

如果结束

%>

使用方法:

把上面的代码放在上面!

IPString="|45.125.14.95|183.56.168.84|127.0.0.1|120.55.38.50|47.90.121.181|"是采集你网站content的垃圾服务器IP,可以自己替换,不知道的别人的服务器IP,点击开始------运行-----输入ping *****.com(采集网站 URL)获取它的IP。

另外,127.0.0.1是防止本地采集,你可以在本地试试,因为现在很多新的网站来自本地采集,所以这个127.0.0.1 必须被屏蔽。现在很多网站程序都有屏蔽IP的功能,上面的代码就不用了,直接屏蔽服务器IP即可!

六、一些防止文章成为采集的简单方法

除了上面的方法,我还整理了以下可以手头实现的方法。我觉得还是有一定的效果的。现在我将与您分享:

1、加水印

当你的文章里有图片时,记得给文章里的图片加水印,这样你的版权就有了。对方想要采集你的文章后,不可能一一去PS,也算是帮我们变相宣传网站了。

2、穿塞信息

写文章时,尽量随机插入一些你的网站姓名、链接、作者等信息,只要能流畅阅读,尽量多加。如果对方想要采集你的文章,他也会花很多时间去处理。久而久之,他就不愿意采集我们的文章。同时,对于粗心大意的采集,留下你的留言。

3、留内链

在你的内容中适当添加一些内链,但不要添加太多,在3个以内(详见马海翔博客“网站内链结构如何布局”相关介绍)。

4、临时请假错误

这个方法很巧妙。如果你发现某个站正在盯上你,你应该定期采集你的文章内容时。发布文章时可以故意写错或添加一些不好的词汇。发文章 的时候可能会出错几行代码。看到他采集过去后,你可以自己快速更改。可以让他的用户体验降低。但是,我想提醒您,这种方法是不推荐的。万一你的用户此时看到你的文章,也会对你产生影响,所以这种情况只适合刚入门的小网站。

该方法的具体方法是在文章的每段任意位置添加一些无用字符,然后将这些字符的颜色设置为白色,将这些字符的大小设置为0。

代码如下:

/^! |7 c; i1 T" x1 Q$ X1 \) G) C

此方法可以轻松防止软件从采集到他的文章内容。

其实很多人都用他的网站 URL,而不是用无用的字符。这样,当你复制他的文章并直接发布时,你会带上他的网址,并给他网站一个额外的链。

所以遇到这样的网站反采集、采集需要手动删除这些多余的字符。

但是,在防止采集的同时,文章也有很多无用的字符,不利于文章SEO优化。

5、URL 提交

先把文章的网址提交给百度,两天后发布文章。这时候百度可能有收录你的文章。就算对方再次来采集,也不会产生这么大的影响(具体可以参考马海翔的博客《采集的文章如何快速内容收录和排名》相关介绍).

6、重要内容设置会员访问限制

如果你的网站里面确实有重要的内容,你需要保留它,这样固定的资源才能吸引固定的用户。这样,您可以设置会员访问限制,以便注册会员或高级会员可以访问这部分内容。

当然,这也会把搜索引擎拒之门外,但为了保持网站的吸引力,必须保留适当的稀有资源。如果网站没有用户留下的资源,那么用户很容易离开。

当然,防止采集的方法有很多,大家可以去专业网站学习模仿。马海翔觉得,如果是新网站要通过原创内容增加权重,还是要防范采集;如果网站发展了很多,就没有必要阻止采集,毕竟搜索引擎已经认识到这是文章的起点。

最后提醒大家,因为每个网站根据使用时间和布局可能会在一些系统模板代码上略有差异,所以建议修改前保存一份源代码拷贝到避免意外误操作导致整个网站丢失。

马海翔的博客评论:

其实,无论技术和方法多么巧妙,也无法阻止原创文章被他人抄袭。只能起到一定的作用,就是增加对方的工作量。最有效的办法是大家遵守规则,要么自己原创,要么直接转载文章并保留文章的出处,或者做一个大规模的伪原创。对于现在的网络氛围,我觉得这种抄袭还需要很多年才能减少。真的很难治愈。 查看全部

文章页模板中加入版权信息的功能,你知道吗?

最好的用户体验是允许复制,但我们可以为复制的内容添加版权信息。很多网站已经开始使用这种方法了。

具体方法是:找到系统后台-模块-默认模块管理-文章page模板并添加如下代码,你可以试试,在IE内核浏览器中,复制内容时可以自动添加版权网页正文信息功能!

JavaScript 代码:

二、使文章页面无法复制代码

在系统后台的默认模块管理中找到footer.htm,或者文章页面模板的底部代码模块,在页面文件末尾添加如下代码,并保存。

另外,禁用复制功能也是很多人用来防止复制和采集的方法。对于采集文章这种类型的保护,只能在“查看源文件”NS中使用他的文章内容。不过,破解的方法已经很多了。俗话说有政策有对策,但对抄袭者起到了制造麻烦的作用,并不是每个人都学会了“破解方法”,所以还是建议大家使用反抄袭策略。

三、use anti采集code

其实普通的采集工具一般都要求内容起始码和结束码的唯一性。所以我们可以从文章页面开始

添加一段id="{dede:field.id/}"让文章自动获取文章ID,如下图:

这样每个文章的ID都不一样,所以采集工具采集时,每次只能采集一个文章,可以有效防止低级采集工具采集,但是高级的采集工具未必能防!

四、set DEDE自带反采集string

DEDE 有自己的采集string-proof 功能。通过设置采集string-proof功能,可以让其他人的采集文章出现在字符串后面,影响阅读,让采集的网站不得不放弃采集 .

反采集Miscellaneous string management 停止设置需要后,可以增加或减少被采集隐藏后出现的内容,通常可以参与一些版权声明或者你的网站相关信息。设置方法只需要在“#start#”和“#end#”之间输入内容,在每个内容前加上“#”,一个内容为一行,里面的内容会随机插入到生成的html中,按下图停止设置。

当然,这并非万无一失。它高一英尺,高一英尺。如果采集字符串较少,可以用一点采集规则替换那些无意义的字符串;如果有更多的字符串,这会稀释文章的关键词密度。

另外,有几个人建议直接使用网站keywords 和网站 链接作为字符串。据说这样可以增加网站外链。其他人采集 得到的越多,外部链接就越多。马海翔对这种做法持保留态度。毕竟,设置反采集String 与 SEO 作弊非常相似。所以目前很多网站都没有设置这个功能,不知道是不是这个原因。

五、封采集器的IP

为了防止采集,大部分方法都是“双刃剑”。采用IP阻塞方式,防止采集返回不成功。实践证明,这种方法永远不会影响search收录。

具体代码如下:

0 那么

response.write “您的 IP 已被禁止”

响应结束

如果结束

%>

使用方法:

把上面的代码放在上面!

IPString="|45.125.14.95|183.56.168.84|127.0.0.1|120.55.38.50|47.90.121.181|"是采集你网站content的垃圾服务器IP,可以自己替换,不知道的别人的服务器IP,点击开始------运行-----输入ping *****.com(采集网站 URL)获取它的IP。

另外,127.0.0.1是防止本地采集,你可以在本地试试,因为现在很多新的网站来自本地采集,所以这个127.0.0.1 必须被屏蔽。现在很多网站程序都有屏蔽IP的功能,上面的代码就不用了,直接屏蔽服务器IP即可!

六、一些防止文章成为采集的简单方法

除了上面的方法,我还整理了以下可以手头实现的方法。我觉得还是有一定的效果的。现在我将与您分享:

1、加水印

当你的文章里有图片时,记得给文章里的图片加水印,这样你的版权就有了。对方想要采集你的文章后,不可能一一去PS,也算是帮我们变相宣传网站了。

2、穿塞信息

写文章时,尽量随机插入一些你的网站姓名、链接、作者等信息,只要能流畅阅读,尽量多加。如果对方想要采集你的文章,他也会花很多时间去处理。久而久之,他就不愿意采集我们的文章。同时,对于粗心大意的采集,留下你的留言。

3、留内链

在你的内容中适当添加一些内链,但不要添加太多,在3个以内(详见马海翔博客“网站内链结构如何布局”相关介绍)。

4、临时请假错误

这个方法很巧妙。如果你发现某个站正在盯上你,你应该定期采集你的文章内容时。发布文章时可以故意写错或添加一些不好的词汇。发文章 的时候可能会出错几行代码。看到他采集过去后,你可以自己快速更改。可以让他的用户体验降低。但是,我想提醒您,这种方法是不推荐的。万一你的用户此时看到你的文章,也会对你产生影响,所以这种情况只适合刚入门的小网站。

该方法的具体方法是在文章的每段任意位置添加一些无用字符,然后将这些字符的颜色设置为白色,将这些字符的大小设置为0。

代码如下:

/^! |7 c; i1 T" x1 Q$ X1 \) G) C

此方法可以轻松防止软件从采集到他的文章内容。

其实很多人都用他的网站 URL,而不是用无用的字符。这样,当你复制他的文章并直接发布时,你会带上他的网址,并给他网站一个额外的链。

所以遇到这样的网站反采集、采集需要手动删除这些多余的字符。

但是,在防止采集的同时,文章也有很多无用的字符,不利于文章SEO优化。

5、URL 提交

先把文章的网址提交给百度,两天后发布文章。这时候百度可能有收录你的文章。就算对方再次来采集,也不会产生这么大的影响(具体可以参考马海翔的博客《采集的文章如何快速内容收录和排名》相关介绍).

6、重要内容设置会员访问限制

如果你的网站里面确实有重要的内容,你需要保留它,这样固定的资源才能吸引固定的用户。这样,您可以设置会员访问限制,以便注册会员或高级会员可以访问这部分内容。

当然,这也会把搜索引擎拒之门外,但为了保持网站的吸引力,必须保留适当的稀有资源。如果网站没有用户留下的资源,那么用户很容易离开。

当然,防止采集的方法有很多,大家可以去专业网站学习模仿。马海翔觉得,如果是新网站要通过原创内容增加权重,还是要防范采集;如果网站发展了很多,就没有必要阻止采集,毕竟搜索引擎已经认识到这是文章的起点。

最后提醒大家,因为每个网站根据使用时间和布局可能会在一些系统模板代码上略有差异,所以建议修改前保存一份源代码拷贝到避免意外误操作导致整个网站丢失。

马海翔的博客评论:

其实,无论技术和方法多么巧妙,也无法阻止原创文章被他人抄袭。只能起到一定的作用,就是增加对方的工作量。最有效的办法是大家遵守规则,要么自己原创,要么直接转载文章并保留文章的出处,或者做一个大规模的伪原创。对于现在的网络氛围,我觉得这种抄袭还需要很多年才能减少。真的很难治愈。

免费代理稳定性连同时切换代理附代理采集下载下载地址

采集交流 • 优采云 发表了文章 • 0 个评论 • 187 次浏览 • 2021-08-11 21:19

1、Proxy 文件格式:(Proxy采集Address)

2、Free agent 稳定性不可靠,同时使用装饰器重连切换代理

# coding: utf-8

# pyhotn 2.7

# 小说棋 单篇小说采集 http://www.xs7.la/

# 替换第一章地址,总章节数。

# ip.txt 为代理池。

import urllib2

from bs4 import BeautifulSoup

import sys

import traceback

import random

import gzip

reload(sys)

sys.setdefaultencoding('utf-8')

f = open("out.txt", "a+")

headers = { "Host": "www.xs7.la", "Accept": "text/html,application/xhtml+xml,application/xml;q=0.9,*/*;q=0.8", "X-Requested-With": "XMLHttpRequest", "User-Agent": "Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/66.0.3359.181 Safari/537.36", "Content-Type": "text/html", "Connection": "keep-alive", "Upgrade-Insecure-Requests": "1", "Referer": "http://www.xs7.la/book/18_18966/", "Accept-Encoding": 'deflat'

}

url = "http://www.xs7.la/book/18_18966/7828246.html" # 第一章网址

page = 184 # 章节数

nextHref = url

ipPool = []

def IPpool(): reader = open('ip.txt') line = reader.readline() while line: if line.strip() != '': ipPool.append(line.split()) line = reader.readline() reader.close()

RETRIES = 0

# 重试的次数

count = {"num": RETRIES}

def conn_try_again(function): def wrapped(*args, **kwargs): try: return function(*args, **kwargs) except Exception, err: print("--重试访问,当前次数 %s ,(总次数11)--" % (count['num'] + 1)) if count['num'] < 10: count['num'] += 1 return wrapped(*args, **kwargs) else: raise Exception(err) return wrapped

bsObj = None

#判断编码格式

def getCoding(strInput): ''' 获取编码格式 ''' if isinstance(strInput, unicode): return "unicode" try: strInput.decode("utf8") return 'utf8' except: pass try: strInput.decode("gbk") return 'gbk' except: pass @conn_try_again

def getContent(url): global nextHref, page, bsObj # 定义一个代理开关 proxySwitch = True try: poolLen = len(ipPool) if (poolLen > 0): i = random.randint(0, poolLen - 1) print(ipPool[i]) proxy_host = ipPool[i][2] + "://" + ipPool[i][0] + ":" + ipPool[i][1] proxy_temp = {ipPool[i][2]: proxy_host} proxy_support = urllib2.ProxyHandler(proxy_temp) else: print('--代理池当前无可用代理,使用本机地址访问--') proxy_support = urllib2.ProxyHandler({}) nullproxy_handler = urllib2.ProxyHandler({"http": "124.172.232.49:8010"}) if proxySwitch: opener = urllib2.build_opener(proxy_support) else: opener = urllib2.build_opener(nullproxy_handler) urllib2.install_opener(opener) req = urllib2.Request(url, headers=headers) response = urllib2.urlopen(req, timeout=3) r = response.read() encode=getCoding(r) if(encode==None): print(response.info().get('Content-Encoding')) #gzip需要解压 else : r = r.decode(encode) # print(r) bsObj = BeautifulSoup(r, 'lxml') except Exception, err: raise Exception(err) # print(bsObj) contentDiv = bsObj.find('div', id='content') content = bsObj.find('div', id='content').get_text() preAndNextBar = bsObj.find('div', id='thumb') title = bsObj.find('div', id='bgdiv').h1.get_text() if ("下一章" in preAndNextBar.get_text()): next = None aList = preAndNextBar.findAll('a') for i in aList: if ("下一章" in i.get_text()): next = i if (next == None): print("下一章为空") return True nextHref = next.get('href') print(title) # print(content) print(nextHref) f.write("#####" + '\n') f.write(title + '\n') f.write(content + '\n') count['num'] = 0 else: return True

def main(): IPpool() global page try: for num in range(1, page): if (getContent(nextHref)): break print("--- end ---") except Exception, e: print(traceback.print_exc()) finally: f.close()

main()

附件:Agent采集

下载链接: 查看全部

免费代理稳定性连同时切换代理附代理采集下载下载地址

1、Proxy 文件格式:(Proxy采集Address)

2、Free agent 稳定性不可靠,同时使用装饰器重连切换代理

# coding: utf-8

# pyhotn 2.7

# 小说棋 单篇小说采集 http://www.xs7.la/

# 替换第一章地址,总章节数。

# ip.txt 为代理池。

import urllib2

from bs4 import BeautifulSoup

import sys

import traceback

import random

import gzip

reload(sys)

sys.setdefaultencoding('utf-8')

f = open("out.txt", "a+")

headers = { "Host": "www.xs7.la", "Accept": "text/html,application/xhtml+xml,application/xml;q=0.9,*/*;q=0.8", "X-Requested-With": "XMLHttpRequest", "User-Agent": "Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/66.0.3359.181 Safari/537.36", "Content-Type": "text/html", "Connection": "keep-alive", "Upgrade-Insecure-Requests": "1", "Referer": "http://www.xs7.la/book/18_18966/", "Accept-Encoding": 'deflat'

}

url = "http://www.xs7.la/book/18_18966/7828246.html" # 第一章网址

page = 184 # 章节数

nextHref = url

ipPool = []

def IPpool(): reader = open('ip.txt') line = reader.readline() while line: if line.strip() != '': ipPool.append(line.split()) line = reader.readline() reader.close()

RETRIES = 0

# 重试的次数

count = {"num": RETRIES}

def conn_try_again(function): def wrapped(*args, **kwargs): try: return function(*args, **kwargs) except Exception, err: print("--重试访问,当前次数 %s ,(总次数11)--" % (count['num'] + 1)) if count['num'] < 10: count['num'] += 1 return wrapped(*args, **kwargs) else: raise Exception(err) return wrapped

bsObj = None

#判断编码格式

def getCoding(strInput): ''' 获取编码格式 ''' if isinstance(strInput, unicode): return "unicode" try: strInput.decode("utf8") return 'utf8' except: pass try: strInput.decode("gbk") return 'gbk' except: pass @conn_try_again

def getContent(url): global nextHref, page, bsObj # 定义一个代理开关 proxySwitch = True try: poolLen = len(ipPool) if (poolLen > 0): i = random.randint(0, poolLen - 1) print(ipPool[i]) proxy_host = ipPool[i][2] + "://" + ipPool[i][0] + ":" + ipPool[i][1] proxy_temp = {ipPool[i][2]: proxy_host} proxy_support = urllib2.ProxyHandler(proxy_temp) else: print('--代理池当前无可用代理,使用本机地址访问--') proxy_support = urllib2.ProxyHandler({}) nullproxy_handler = urllib2.ProxyHandler({"http": "124.172.232.49:8010"}) if proxySwitch: opener = urllib2.build_opener(proxy_support) else: opener = urllib2.build_opener(nullproxy_handler) urllib2.install_opener(opener) req = urllib2.Request(url, headers=headers) response = urllib2.urlopen(req, timeout=3) r = response.read() encode=getCoding(r) if(encode==None): print(response.info().get('Content-Encoding')) #gzip需要解压 else : r = r.decode(encode) # print(r) bsObj = BeautifulSoup(r, 'lxml') except Exception, err: raise Exception(err) # print(bsObj) contentDiv = bsObj.find('div', id='content') content = bsObj.find('div', id='content').get_text() preAndNextBar = bsObj.find('div', id='thumb') title = bsObj.find('div', id='bgdiv').h1.get_text() if ("下一章" in preAndNextBar.get_text()): next = None aList = preAndNextBar.findAll('a') for i in aList: if ("下一章" in i.get_text()): next = i if (next == None): print("下一章为空") return True nextHref = next.get('href') print(title) # print(content) print(nextHref) f.write("#####" + '\n') f.write(title + '\n') f.write(content + '\n') count['num'] = 0 else: return True

def main(): IPpool() global page try: for num in range(1, page): if (getContent(nextHref)): break print("--- end ---") except Exception, e: print(traceback.print_exc()) finally: f.close()

main()

附件:Agent采集

下载链接:

优采云万能文章采集器绿色免费破解版,双击即可打开使用(组图)

采集交流 • 优采云 发表了文章 • 0 个评论 • 165 次浏览 • 2021-08-04 18:52

文章采集器免费版(Duo Duo Quick Spider)是一款专业的网络采集工具;软件使用MongoDB数据库,可以帮助用户快速采集文章。

本编辑器为您带来优采云万能文章采集器绿色免费破解版,双击打开使用,软件已经完美破解,无需注册码激活即可免费使用,喜欢的用户欢迎从本站下载。特色一、天才于优采云软件唯万。

文章采集器免费版快速破解网站自带的文章量多优采云自.

文章采集是一款非常实用的最新文章采集神器,这里免费为大家带来最新强大的文章采集软件,一个关键词即可快速。

Universal文章采集器v3.0.8.0 绿色免费版 一些用户可能经常需要更新一些文章,Universal文章采集器是一种可以到文章批量下载采集的工具,如果你对某个关键词文章感兴趣,或者你想批量下载。

Universal文章采集器是一款方便易用的文章采集软件,功能强大,完全免费使用。该软件操作简单,可以准确提取网页正文部分并保存为文章,支持标签、链接、邮件等格式处理,只需几分钟。

优采云万能文章采集器本软件官方售价400元。有网友分享了破解版,我在这里分享给需要的用户!

Universal文章采集器是一款方便易用的文章采集软件,功能强大,完全免费使用。该软件操作简单,可以准确提取网页。 查看全部

优采云万能文章采集器绿色免费破解版,双击即可打开使用(组图)

文章采集器免费版(Duo Duo Quick Spider)是一款专业的网络采集工具;软件使用MongoDB数据库,可以帮助用户快速采集文章。

本编辑器为您带来优采云万能文章采集器绿色免费破解版,双击打开使用,软件已经完美破解,无需注册码激活即可免费使用,喜欢的用户欢迎从本站下载。特色一、天才于优采云软件唯万。

文章采集器免费版快速破解网站自带的文章量多优采云自.

文章采集是一款非常实用的最新文章采集神器,这里免费为大家带来最新强大的文章采集软件,一个关键词即可快速。

Universal文章采集器v3.0.8.0 绿色免费版 一些用户可能经常需要更新一些文章,Universal文章采集器是一种可以到文章批量下载采集的工具,如果你对某个关键词文章感兴趣,或者你想批量下载。

Universal文章采集器是一款方便易用的文章采集软件,功能强大,完全免费使用。该软件操作简单,可以准确提取网页正文部分并保存为文章,支持标签、链接、邮件等格式处理,只需几分钟。

优采云万能文章采集器本软件官方售价400元。有网友分享了破解版,我在这里分享给需要的用户!

Universal文章采集器是一款方便易用的文章采集软件,功能强大,完全免费使用。该软件操作简单,可以准确提取网页。

技巧:文章采集伪原创工具_如何去进行文章伪原创?

采集交流 • 优采云 发表了文章 • 0 个评论 • 260 次浏览 • 2021-01-16 10:02

如果您不熟悉SEO,建议您先进行研究,以更好地编写文章。[p19]。

收录不是哪种内容?了解这一点后,您可以转到伪原创。做一件事以了解并简化它。

让我向您介绍我去过伪原创的方式:

1.先到网络采集相关信息(您可以使用文章 采集器采集 文章)

由2.和关键词搜索的

文章可以分为三、六、九个,以此类推。查询数据的标题取决于网络的重复率,三个重复之内

其中三到五个,而不是五个。

3.我通常只在3点之内完成伪原创,但是除了3至5点我什么都没做。

首先,文章是第一个修改标题的人。对于伪原创,这是最重要的事情,例如:

原语:伪原创怎么办?

更改:如何正确使用文章 伪原创? (更加全面,搜索点击次数将略有改善。)

更改:如何正确编写高质量的伪原创内容? (这比上一个要好。它收录所有内容,搜索结果可能会更好。)

标题的具体分析和修改应在原创标题的基础上进行更改,但含义没有改变。

然后进行内容校正:

1.首先仔细阅读采集中的信息。

2. 文章必须在文章的开头和结尾再次转到原创,并且不要全部转到伪原创 伪原创。

3.删除您认为不好的原创写作,然后文章添加您的文字,也可以将这两篇写得很好的文章合并。

以上是作者自己的学习和知识共享,希望对您有帮助 查看全部

技巧:文章采集伪原创工具_如何去进行文章伪原创?

如果您不熟悉SEO,建议您先进行研究,以更好地编写文章。[p19]。

收录不是哪种内容?了解这一点后,您可以转到伪原创。做一件事以了解并简化它。

让我向您介绍我去过伪原创的方式:

1.先到网络采集相关信息(您可以使用文章 采集器采集 文章)

由2.和关键词搜索的

文章可以分为三、六、九个,以此类推。查询数据的标题取决于网络的重复率,三个重复之内

其中三到五个,而不是五个。

3.我通常只在3点之内完成伪原创,但是除了3至5点我什么都没做。

首先,文章是第一个修改标题的人。对于伪原创,这是最重要的事情,例如:

原语:伪原创怎么办?

更改:如何正确使用文章 伪原创? (更加全面,搜索点击次数将略有改善。)

更改:如何正确编写高质量的伪原创内容? (这比上一个要好。它收录所有内容,搜索结果可能会更好。)

标题的具体分析和修改应在原创标题的基础上进行更改,但含义没有改变。

然后进行内容校正:

1.首先仔细阅读采集中的信息。

2. 文章必须在文章的开头和结尾再次转到原创,并且不要全部转到伪原创 伪原创。

3.删除您认为不好的原创写作,然后文章添加您的文字,也可以将这两篇写得很好的文章合并。

以上是作者自己的学习和知识共享,希望对您有帮助

如何解决网站文章被剽窃?

采集交流 • 优采云 发表了文章 • 0 个评论 • 185 次浏览 • 2020-08-26 04:27

现阶段有很多的网站都会选择使用采集文章或者剽窃文章的形式,来做网站的内容更新,其实这些更新的方法在百度官方早就给出明晰的意见,想要了解更多的小伙伴们可以去百度站长平台详尽的阅读一下百度官方的说明。那么接下来我就想要跟你们阐述一下文章采集的影响以及如何可以解决被剽窃呢?

网站文章是不是可以通过采集来完成呢?

因为搜索引擎现阶段是越来越智能,同时也在指出用户体验和附加价值,如果我们只是在大批量的去做文章采集的话,可能会造成以下的问题出现。

一,是网站采集回来的内容不一定是符合网站主题的内容,这样的内容都会被搜索引擎判断为低质量垃圾内容,严重的话也可能会使网站被降权。

二,长时间大批量的采集文章内容的同时会对服务器带来一定的压力,假如使用的虚拟空间,容量又太小,就有一定的可能使使虚拟空间的显存满掉然后不能进行操作,这样的话岂不是得不偿失。

如何解决网站文章被剽窃?

一,我们须要把自己网站的内部调整做好,同时须要对网站养成固定时间的更新频度,这样操作以后,对网站的收录有很大的提高。

二,在我们网站的原创文章更新以后,可以选择使用百度站长平台的原创保护功能,在每次更新文章之后去递交一下原创保护吗,每天原创保护可以递交10条。

三,对方在采集我们文章的时侯,图片也会被采集,我们可以在文章中的图片添加图片水印。

我觉得现今不仅百度官方对文章采集站点的处理之外,我们可以把自己的网站打造的更好,这样才可以使自己网站收录做到更好。 查看全部

如何解决网站文章被剽窃?

现阶段有很多的网站都会选择使用采集文章或者剽窃文章的形式,来做网站的内容更新,其实这些更新的方法在百度官方早就给出明晰的意见,想要了解更多的小伙伴们可以去百度站长平台详尽的阅读一下百度官方的说明。那么接下来我就想要跟你们阐述一下文章采集的影响以及如何可以解决被剽窃呢?

网站文章是不是可以通过采集来完成呢?

因为搜索引擎现阶段是越来越智能,同时也在指出用户体验和附加价值,如果我们只是在大批量的去做文章采集的话,可能会造成以下的问题出现。

一,是网站采集回来的内容不一定是符合网站主题的内容,这样的内容都会被搜索引擎判断为低质量垃圾内容,严重的话也可能会使网站被降权。

二,长时间大批量的采集文章内容的同时会对服务器带来一定的压力,假如使用的虚拟空间,容量又太小,就有一定的可能使使虚拟空间的显存满掉然后不能进行操作,这样的话岂不是得不偿失。

如何解决网站文章被剽窃?

一,我们须要把自己网站的内部调整做好,同时须要对网站养成固定时间的更新频度,这样操作以后,对网站的收录有很大的提高。

二,在我们网站的原创文章更新以后,可以选择使用百度站长平台的原创保护功能,在每次更新文章之后去递交一下原创保护吗,每天原创保护可以递交10条。

三,对方在采集我们文章的时侯,图片也会被采集,我们可以在文章中的图片添加图片水印。

我觉得现今不仅百度官方对文章采集站点的处理之外,我们可以把自己的网站打造的更好,这样才可以使自己网站收录做到更好。

文章采集(php采集文章图片不显示的解决办法:1、根据关键字采集百度搜寻结果)

采集交流 • 优采云 发表了文章 • 0 个评论 • 176 次浏览 • 2021-10-20 14:17

php采集文章图片不显示的解决方法:1、根据关键字采集百度搜索结果; 2、把采集放到Html中,根据定义的域名做批量转换即可。

本文运行环境:windows7系统,PHP7.版本1,DELL G3电脑

php采集文章图片不显示怎么办?

PHP CURL采集百度搜索结果图片不显示问题的解决方法

1.根据关键字采集百度搜索结果

根据关键字采集百度搜索结果,可以使用curl来实现,代码如下:

<p>

</p>

输出后发现有些图片无法显示

2.采集显示后图片不显示原因分析

直接在百度搜索,页面可以显示图片。使用firebug查看图片路径,发现采集的图片域名与百度搜索的图片域名不同。

采集返回的图片域名

用于普通搜索的图像域

查看采集和正常搜索html,发现有不同的域名转换js

采集

普通搜索

<p>var list = {

"graph.baidu.com": "https://sp0.baidu.com/-aYHfD0a2gU2pMbgoY3K",

"t1.baidu.com":"https://ss0.baidu.com/6ON1bjeh1BF3odCf",

"t2.baidu.com":"https://ss1.baidu.com/6OZ1bjeh1BF3odCf",

"t3.baidu.com":"https://ss2.baidu.com/6OV1bjeh1BF3odCf",

"t10.baidu.com":"https://ss0.baidu.com/6ONWsjip0QIZ8tyhnq",

"t11.baidu.com":"https://ss1.baidu.com/6ONXsjip0QIZ8tyhnq",

"t12.baidu.com":"https://ss2.baidu.com/6ONYsjip0QIZ8tyhnq",

"i7.baidu.com":"https://ss0.baidu.com/73F1bjeh1BF3odCf",

"i8.baidu.com":"https://ss0.baidu.com/73x1bjeh1BF3odCf",

"i9.baidu.com":"https://ss0.baidu.com/73t1bjeh1BF3odCf",

};

</p>

因此,根据源地址、IP、header等参数可以断定,如果是采集,百度会返回不同的js。

3.采集图片不显示后的解决方法

根据定义的域名批量传输采集中的html。

<p>

</p>

添加域名转换后,所有图片均可正常显示。

推荐学习:《PHP视频教程》

以上是php采集文章的详细内容,图片没有说明怎么做。更多详情请关注php中文网等相关文章!

免责声明:本文由原创发表于php中文网。转载请注明出处。感谢您的尊重!如果您有任何问题,请联系我们 查看全部

文章采集(php采集文章图片不显示的解决办法:1、根据关键字采集百度搜寻结果)

php采集文章图片不显示的解决方法:1、根据关键字采集百度搜索结果; 2、把采集放到Html中,根据定义的域名做批量转换即可。

本文运行环境:windows7系统,PHP7.版本1,DELL G3电脑

php采集文章图片不显示怎么办?

PHP CURL采集百度搜索结果图片不显示问题的解决方法

1.根据关键字采集百度搜索结果

根据关键字采集百度搜索结果,可以使用curl来实现,代码如下:

<p>

</p>

输出后发现有些图片无法显示

2.采集显示后图片不显示原因分析

直接在百度搜索,页面可以显示图片。使用firebug查看图片路径,发现采集的图片域名与百度搜索的图片域名不同。

采集返回的图片域名

用于普通搜索的图像域

查看采集和正常搜索html,发现有不同的域名转换js

采集

普通搜索

<p>var list = {

"graph.baidu.com": "https://sp0.baidu.com/-aYHfD0a2gU2pMbgoY3K",

"t1.baidu.com":"https://ss0.baidu.com/6ON1bjeh1BF3odCf",

"t2.baidu.com":"https://ss1.baidu.com/6OZ1bjeh1BF3odCf",

"t3.baidu.com":"https://ss2.baidu.com/6OV1bjeh1BF3odCf",

"t10.baidu.com":"https://ss0.baidu.com/6ONWsjip0QIZ8tyhnq",

"t11.baidu.com":"https://ss1.baidu.com/6ONXsjip0QIZ8tyhnq",

"t12.baidu.com":"https://ss2.baidu.com/6ONYsjip0QIZ8tyhnq",

"i7.baidu.com":"https://ss0.baidu.com/73F1bjeh1BF3odCf",

"i8.baidu.com":"https://ss0.baidu.com/73x1bjeh1BF3odCf",

"i9.baidu.com":"https://ss0.baidu.com/73t1bjeh1BF3odCf",

};

</p>

因此,根据源地址、IP、header等参数可以断定,如果是采集,百度会返回不同的js。

3.采集图片不显示后的解决方法

根据定义的域名批量传输采集中的html。

<p>

</p>

添加域名转换后,所有图片均可正常显示。

推荐学习:《PHP视频教程》

以上是php采集文章的详细内容,图片没有说明怎么做。更多详情请关注php中文网等相关文章!

免责声明:本文由原创发表于php中文网。转载请注明出处。感谢您的尊重!如果您有任何问题,请联系我们

文章采集(一下如何用优采云采集器采集器采集文章?的使用方法)

采集交流 • 优采云 发表了文章 • 0 个评论 • 194 次浏览 • 2021-10-14 11:14

优采云采集器如何采集文章?有时候我们看到一个网站的文章,就想保存这些文章。一张一张的复制保存很麻烦。这时候就需要使用优采云采集器保存文章采集,下面分享优采云的用法

有时我们看到一个网站的文章,就想保存这些文章。一张一张的复制保存很麻烦。这时候就需要使用优采云采集器保存文章采集。下面是如何使用优采云采集器采集文章。

软件名称:

QQ宠物经典360题补充(累积更新)

软件大小:

更新时间:

2009-04-27立即下载

第一步,下载采集 URL,下载优采云采集器,打开即可新建一个任意任务名称的任务。将需要采集的网站文章列表页面的URL添加到起始URL。从图中可以看出,列表页有34页,每页有N篇文章文章。

列表页面会获取一级URL,添加多级URL获取二级URL(文章page URL)

设置要通过分页检索的列表。三处分别为:分页源代码前后中间位置。此步骤用于获取列表页链接,因为列表页共有 34 个。设置好后保存。

URL获取选项,此步骤用于获取列表页文章页面的链接,根据自己的需要设置需要拦截的部分,根据需要设置收录或排除某些字符URL 的结构。如果为空,则没有限制,设置后保存。

设置好link采集规则后,可以测试URL,根据测试结果调整规则。看图可以看到采集链接规则已经成功,从初始链接到综合列表页,再到列表页采集上的文章页链接。

第二步是采集的内容。首先修改标题规则,在页面源码中找到标题代码,将标题前后的标题剪掉。节省。

内容修改采集规则类似于title规则,也是在源码中找到的内容前后的代码。这里的内容会有一些其他的html标签,所以你必须添加一个html标签排除规则。

完成测试后,查看结果并从测试结果中调试规则,直到测试结果是您想要的。

第三步是采集导出。1、2的前两步设置规则,最后导出文章。首先制作一个导出的模板。

然后选择方法二,将每篇文章文章记录成txt文本,自己保存位置,选择刚刚制作的模板导出模板。保存的文件名以文章的标题命名。其他默认,保存。

勾选采集 URL、采集内容3个选项框并发布,然后启动采集。完成后,文本会自动生成在刚刚保存的文件夹中。

优采云采集器采集文章教程到此结束。由于每一个网站都不同,这里只能使用一个网站。@>演示只是一种思维方式。您需要 采集文章 才能灵活。

上面是优采云采集器怎么样采集文章?更多详情请关注其他相关html中文网站文章! 查看全部

文章采集(一下如何用优采云采集器采集器采集文章?的使用方法)

优采云采集器如何采集文章?有时候我们看到一个网站的文章,就想保存这些文章。一张一张的复制保存很麻烦。这时候就需要使用优采云采集器保存文章采集,下面分享优采云的用法

有时我们看到一个网站的文章,就想保存这些文章。一张一张的复制保存很麻烦。这时候就需要使用优采云采集器保存文章采集。下面是如何使用优采云采集器采集文章。

软件名称:

QQ宠物经典360题补充(累积更新)

软件大小:

更新时间:

2009-04-27立即下载

第一步,下载采集 URL,下载优采云采集器,打开即可新建一个任意任务名称的任务。将需要采集的网站文章列表页面的URL添加到起始URL。从图中可以看出,列表页有34页,每页有N篇文章文章。

列表页面会获取一级URL,添加多级URL获取二级URL(文章page URL)

设置要通过分页检索的列表。三处分别为:分页源代码前后中间位置。此步骤用于获取列表页链接,因为列表页共有 34 个。设置好后保存。

URL获取选项,此步骤用于获取列表页文章页面的链接,根据自己的需要设置需要拦截的部分,根据需要设置收录或排除某些字符URL 的结构。如果为空,则没有限制,设置后保存。

设置好link采集规则后,可以测试URL,根据测试结果调整规则。看图可以看到采集链接规则已经成功,从初始链接到综合列表页,再到列表页采集上的文章页链接。

第二步是采集的内容。首先修改标题规则,在页面源码中找到标题代码,将标题前后的标题剪掉。节省。

内容修改采集规则类似于title规则,也是在源码中找到的内容前后的代码。这里的内容会有一些其他的html标签,所以你必须添加一个html标签排除规则。

完成测试后,查看结果并从测试结果中调试规则,直到测试结果是您想要的。

第三步是采集导出。1、2的前两步设置规则,最后导出文章。首先制作一个导出的模板。

然后选择方法二,将每篇文章文章记录成txt文本,自己保存位置,选择刚刚制作的模板导出模板。保存的文件名以文章的标题命名。其他默认,保存。

勾选采集 URL、采集内容3个选项框并发布,然后启动采集。完成后,文本会自动生成在刚刚保存的文件夹中。

优采云采集器采集文章教程到此结束。由于每一个网站都不同,这里只能使用一个网站。@>演示只是一种思维方式。您需要 采集文章 才能灵活。

上面是优采云采集器怎么样采集文章?更多详情请关注其他相关html中文网站文章!

文章采集(优采云大数据采集网站:使用功能点:URL列表信息采集 )

采集交流 • 优采云 发表了文章 • 0 个评论 • 204 次浏览 • 2021-09-08 13:23

)

采集网站:

使用功能点:

网址

分页列表信息采集

搜狗微信搜索:搜狗微信搜索是搜狗于2014年6月9日推出的微信公众平台。“微信搜索”支持搜索微信公众号和微信文章,可以通过关键词搜索相关微信公众号@,或文章微信公众号推送。不仅是PC端,搜狗手机搜索客户端也会推荐相关微信公众号。

搜狗微信文章采集数据说明:本文在搜狗微信-搜索-优采云大数据的文章信息采集进行。本文仅以“搜狗微信-搜索-优采云大数据的文章信息采集”为例。实际操作中,您可以根据自己的需要,将搜狗微信的搜索词更改为执行数据采集。

搜狗微信文章采集detail采集字段说明:微信文章title、微信文章keywords、微信文章generalization、微信公众号、微信文章发布时间、微信文章地址。

第一步:创建采集task

1)进入主界面,选择“自定义模式”

2)将采集的网址复制粘贴到网站输入框中,点击“保存网址”

第 2 步:创建翻页循环

1)打开右上角的“进程”。点击页面文章搜索框,在右侧操作提示框中选择“输入文字”

2)输入要搜索的文章信息,这里以搜索“优采云大数据”为例,输入完成后点击“确定”按钮

3)“优采云大数据”会自动填写搜索框,点击“search文章”按钮,在操作提示框中选择“点击此按钮”

“优采云大数据”的文章搜索结果出现在4)页面上。将结果页下拉至底部,点击“下一页”按钮,在右侧操作提示框中选择“循环点击下一页”

第 3 步:创建一个列表循环并提取数据

1)移动鼠标选择页面上的第一个文章块。系统将识别此块中的子元素。在操作提示框中选择“选择子元素”

2)继续选择页面第二篇文章中的区块,系统会自动选择第二篇文章中的子元素,并识别页面上其他10组相似元素, 在操作提示框中,选择“全选”

3) 我们可以看到页面上文章块中的所有元素都被选中并变成了绿色。在右侧的操作提示框中,会出现一个字段预览表。将鼠标移动到表头并单击垃圾桶图标以删除不需要的字段。字段选择完成后,选择“采集以下数据”

4) 因为我们还想要采集 每个文章 URL,所以我们需要再提取一个字段。点击第一篇文章文章的链接,再点击第二篇文章文章的链接,系统会自动在页面上选择一组文章链接。在右侧的操作提示框中选择“采集以下链接地址”

关键词0@

关键词1@字段选择完成后,选择对应的字段,自定义字段的命名。完成后点击左上角的“保存并开始”开始采集task

关键词2@

关键词3@ 选择“启动本地采集”

关键词4@

第四步:数据采集并导出

1)采集完成后会弹出提示,选择“导出数据”,选择“合适的导出方式”,导出采集好搜狗微信文章的数据

关键词6@

2)这里我们选择excel作为导出格式,导出数据如下图

关键词8@ 查看全部

文章采集(优采云大数据采集网站:使用功能点:URL列表信息采集

)

采集网站:

使用功能点:

网址

分页列表信息采集

搜狗微信搜索:搜狗微信搜索是搜狗于2014年6月9日推出的微信公众平台。“微信搜索”支持搜索微信公众号和微信文章,可以通过关键词搜索相关微信公众号@,或文章微信公众号推送。不仅是PC端,搜狗手机搜索客户端也会推荐相关微信公众号。

搜狗微信文章采集数据说明:本文在搜狗微信-搜索-优采云大数据的文章信息采集进行。本文仅以“搜狗微信-搜索-优采云大数据的文章信息采集”为例。实际操作中,您可以根据自己的需要,将搜狗微信的搜索词更改为执行数据采集。

搜狗微信文章采集detail采集字段说明:微信文章title、微信文章keywords、微信文章generalization、微信公众号、微信文章发布时间、微信文章地址。

第一步:创建采集task

1)进入主界面,选择“自定义模式”

2)将采集的网址复制粘贴到网站输入框中,点击“保存网址”

第 2 步:创建翻页循环

1)打开右上角的“进程”。点击页面文章搜索框,在右侧操作提示框中选择“输入文字”

2)输入要搜索的文章信息,这里以搜索“优采云大数据”为例,输入完成后点击“确定”按钮

3)“优采云大数据”会自动填写搜索框,点击“search文章”按钮,在操作提示框中选择“点击此按钮”

“优采云大数据”的文章搜索结果出现在4)页面上。将结果页下拉至底部,点击“下一页”按钮,在右侧操作提示框中选择“循环点击下一页”

第 3 步:创建一个列表循环并提取数据

1)移动鼠标选择页面上的第一个文章块。系统将识别此块中的子元素。在操作提示框中选择“选择子元素”

2)继续选择页面第二篇文章中的区块,系统会自动选择第二篇文章中的子元素,并识别页面上其他10组相似元素, 在操作提示框中,选择“全选”

3) 我们可以看到页面上文章块中的所有元素都被选中并变成了绿色。在右侧的操作提示框中,会出现一个字段预览表。将鼠标移动到表头并单击垃圾桶图标以删除不需要的字段。字段选择完成后,选择“采集以下数据”

4) 因为我们还想要采集 每个文章 URL,所以我们需要再提取一个字段。点击第一篇文章文章的链接,再点击第二篇文章文章的链接,系统会自动在页面上选择一组文章链接。在右侧的操作提示框中选择“采集以下链接地址”

关键词0@

关键词1@字段选择完成后,选择对应的字段,自定义字段的命名。完成后点击左上角的“保存并开始”开始采集task

关键词2@

关键词3@ 选择“启动本地采集”

关键词4@

第四步:数据采集并导出

1)采集完成后会弹出提示,选择“导出数据”,选择“合适的导出方式”,导出采集好搜狗微信文章的数据

关键词6@

2)这里我们选择excel作为导出格式,导出数据如下图

关键词8@

文章采集(如何采集文章做优质的伪原创呢?(图))

采集交流 • 优采云 发表了文章 • 0 个评论 • 180 次浏览 • 2021-09-08 05:16

4.页面信息完整。

有朋友在做网站原创文章的时候发现我们坚持每天更新原创的文章。为什么收录少,排名低?为什么其他网站的伪原创文章排名高?

其实不管是原创文章还是采集,伪原创的文章都是为了解决用户的需求。写文章的出发点也应该是这个,而且要配图文。 ,让用户有更好的阅读体验,符合文章高质量的特点,如果排版凌乱,文章内容与文章标题不匹配,内容对用户,并不能很好地解决。用户的问题,即使文章原创度数高,搜索引擎也会认为这个文章垃圾文章。相反,如果我们关注用户的需求和体验,为了解决用户的问题,我们会做高质量的伪原创文章,那么搜索引擎就会认为这个文章是一个高质量的文章,从而加速收录并提高网站排名。

那我们采集文章如何制作高质量的伪原创?当我们做伪原创文章时,我们可以先整合相关信息。对于采集,我们得去采集学习一些文章更高排名的页面,把这些采集文章整合@所有优质内容,然后用通俗的语言用图片来表达和文本。我们在写伪原创文章的时候,一定要有不同的观点,这样才能让整个文章比原来的文章更全面,提升用户的浏览体验。比如我们可以修改一些不是同顺的文章的句子,文章中的一些错别字,去掉原来文章中的一些广告内容、超链接、水印图片、图标等。 伪原创的文章和原来采集的文章的相似度应该不会太高。如果相似度达到80%,那么搜索引擎就会认为我们的网站文章是抄袭。 文章中的图片不要随意添加。添加的图片最好对用户有帮助。 查看全部

文章采集(如何采集文章做优质的伪原创呢?(图))

4.页面信息完整。

有朋友在做网站原创文章的时候发现我们坚持每天更新原创的文章。为什么收录少,排名低?为什么其他网站的伪原创文章排名高?

其实不管是原创文章还是采集,伪原创的文章都是为了解决用户的需求。写文章的出发点也应该是这个,而且要配图文。 ,让用户有更好的阅读体验,符合文章高质量的特点,如果排版凌乱,文章内容与文章标题不匹配,内容对用户,并不能很好地解决。用户的问题,即使文章原创度数高,搜索引擎也会认为这个文章垃圾文章。相反,如果我们关注用户的需求和体验,为了解决用户的问题,我们会做高质量的伪原创文章,那么搜索引擎就会认为这个文章是一个高质量的文章,从而加速收录并提高网站排名。

那我们采集文章如何制作高质量的伪原创?当我们做伪原创文章时,我们可以先整合相关信息。对于采集,我们得去采集学习一些文章更高排名的页面,把这些采集文章整合@所有优质内容,然后用通俗的语言用图片来表达和文本。我们在写伪原创文章的时候,一定要有不同的观点,这样才能让整个文章比原来的文章更全面,提升用户的浏览体验。比如我们可以修改一些不是同顺的文章的句子,文章中的一些错别字,去掉原来文章中的一些广告内容、超链接、水印图片、图标等。 伪原创的文章和原来采集的文章的相似度应该不会太高。如果相似度达到80%,那么搜索引擎就会认为我们的网站文章是抄袭。 文章中的图片不要随意添加。添加的图片最好对用户有帮助。

文章采集(的是《网络爬虫如何采集页面》的SEO技术分享)

采集交流 • 优采云 发表了文章 • 0 个评论 • 150 次浏览 • 2021-09-01 03:08

文章directory

Information采集是搜索引擎工作的重要组成部分,网络爬虫起着非常重要的作用。

今天,智梦科技小编带来了《如何爬网爬虫采集页》。希望本次SEO技术分享对大家有所帮助。

一、网络爬虫在网络信息中的任务采集

网络信息采集中网络爬虫的两个任务:

①发现网址

网络爬虫的任务之一是查找 URL,通常以一些种子 网站 作为起点。

②下载页面

一般搜索引擎的网络爬虫找到URL后,判断链接是否为收录,链接是否与收录链接非常相似,是否是优质内容,原创多少学位等,然后决定是否需要下载此页面。

二、网络爬虫在information采集中的策略

通常网络爬虫对information采集使用以下方法:

① 从种子开始网站采集

网络爬虫将从一批预先选定的种子网站开始爬取和爬取。这批种子网站通常是最权威的网站。通常一旦一个页面被下载,页面就会被解析并找到链接标签。如果它收录可抓取的 URL 链接,它可能会继续沿此链接抓取。而这个锚文本链接就是这个页面到另一个页面的描述,但是纯文本链接没有这个描述,所以效果差不多。

② 网络爬虫使用多线程

如果是单线程,效率会很低,因为等待服务器响应会花费很多时间,所以启用多线程来提高信息采集的效率。

多线程可能一次爬取数百个页面,这对搜索引擎来说是好事,但对其他人的网站不一定是好事。比如可能会导致对方服务器拥塞,导致一些真实的用户无法正常访问网站。

③ 网络爬虫的爬取策略

网络爬虫不会同时抓取多个页面到同一个网络服务器,每次抓取之间会有一定的间隔。使用该策略时,请求队列一定要特别大,以免降低爬取效率。

比如一个网络爬虫每秒可以抓取1000个页面,同一个网站每次抓取间隔为10秒,所以队列应该是来自10000个不同服务器的URL。

一般情况下,如果您发现搜索引擎抓取频率过高,可以在官方进行调整或反馈。如果不想让搜索引擎抓取某些页面或整个网站,则需要将robots 设置在网站root 目录下。 txt文件没问题。以上内容由智梦科技编辑提供,仅供参考! 查看全部

文章采集(的是《网络爬虫如何采集页面》的SEO技术分享)

文章directory

Information采集是搜索引擎工作的重要组成部分,网络爬虫起着非常重要的作用。

今天,智梦科技小编带来了《如何爬网爬虫采集页》。希望本次SEO技术分享对大家有所帮助。

https://www.4xseo.com/wp-conte ... 0.jpg 270w, https://www.4xseo.com/wp-conte ... 1.jpg 300w" />

https://www.4xseo.com/wp-conte ... 0.jpg 270w, https://www.4xseo.com/wp-conte ... 1.jpg 300w" />一、网络爬虫在网络信息中的任务采集

网络信息采集中网络爬虫的两个任务:

①发现网址

网络爬虫的任务之一是查找 URL,通常以一些种子 网站 作为起点。

②下载页面

一般搜索引擎的网络爬虫找到URL后,判断链接是否为收录,链接是否与收录链接非常相似,是否是优质内容,原创多少学位等,然后决定是否需要下载此页面。

二、网络爬虫在information采集中的策略

通常网络爬虫对information采集使用以下方法:

① 从种子开始网站采集

网络爬虫将从一批预先选定的种子网站开始爬取和爬取。这批种子网站通常是最权威的网站。通常一旦一个页面被下载,页面就会被解析并找到链接标签。如果它收录可抓取的 URL 链接,它可能会继续沿此链接抓取。而这个锚文本链接就是这个页面到另一个页面的描述,但是纯文本链接没有这个描述,所以效果差不多。

② 网络爬虫使用多线程

如果是单线程,效率会很低,因为等待服务器响应会花费很多时间,所以启用多线程来提高信息采集的效率。

多线程可能一次爬取数百个页面,这对搜索引擎来说是好事,但对其他人的网站不一定是好事。比如可能会导致对方服务器拥塞,导致一些真实的用户无法正常访问网站。

③ 网络爬虫的爬取策略

网络爬虫不会同时抓取多个页面到同一个网络服务器,每次抓取之间会有一定的间隔。使用该策略时,请求队列一定要特别大,以免降低爬取效率。

比如一个网络爬虫每秒可以抓取1000个页面,同一个网站每次抓取间隔为10秒,所以队列应该是来自10000个不同服务器的URL。

一般情况下,如果您发现搜索引擎抓取频率过高,可以在官方进行调整或反馈。如果不想让搜索引擎抓取某些页面或整个网站,则需要将robots 设置在网站root 目录下。 txt文件没问题。以上内容由智梦科技编辑提供,仅供参考!

文章采集(文章采集器免费版快速破解网站自带的文章数量多优采云自)

采集交流 • 优采云 发表了文章 • 0 个评论 • 174 次浏览 • 2021-08-30 12:07

文章采集器免费版快速破解网站自带的文章量多优采云自.

文章采集software-文章采集器下载1.0.0.0 免费版-xixi软件下载。

文章采集软件免费版(8m)分享给大家,功能更强大,请注意格式1、login知乎:2、paste知乎工具栏的网址;3、点击“采集文章”按钮:4、点击“浏览器地址”按钮:5、点击“复制网址”按钮。

本编辑器为您带来优采云万能文章采集器绿色免费破解版,双击打开使用,软件已完美破解,无需注册码激活即可免费使用,采集欢迎广大用户从本站下载。特色一、天才于优采云软件唯万。

优采云万能文章采集器是一个可以批量下载指定关键词文章采集的工具,主要帮助用户采集各大平台文章,或者采集Specify网站文章,非常方便快捷,是做网站推广优化的朋友不可多得的选择。

快速破解网站带来的大量文章采集器每日文章,无损加载,压缩包分享到个人朋友圈可以公开下载,也可以转发。

《全民文章采集器免费破解版》是最简单最智能的文章采集器,由优采云software开发,可以采集列表页文章、关键词新闻、微信等,还有定向采集指定网站文章,是一个很好的文章采集器。软件功能 1.

Universal文章采集器v3.0.8.0 绿色免费版 一些用户可能经常需要更新一些文章,而Universal文章采集器是一种可以到文章批量下载采集的工具,如果你对某个关键词文章感兴趣,或者你想批量下载。 查看全部

文章采集(文章采集器免费版快速破解网站自带的文章数量多优采云自)

文章采集器免费版快速破解网站自带的文章量多优采云自.

文章采集software-文章采集器下载1.0.0.0 免费版-xixi软件下载。

文章采集软件免费版(8m)分享给大家,功能更强大,请注意格式1、login知乎:2、paste知乎工具栏的网址;3、点击“采集文章”按钮:4、点击“浏览器地址”按钮:5、点击“复制网址”按钮。

本编辑器为您带来优采云万能文章采集器绿色免费破解版,双击打开使用,软件已完美破解,无需注册码激活即可免费使用,采集欢迎广大用户从本站下载。特色一、天才于优采云软件唯万。

优采云万能文章采集器是一个可以批量下载指定关键词文章采集的工具,主要帮助用户采集各大平台文章,或者采集Specify网站文章,非常方便快捷,是做网站推广优化的朋友不可多得的选择。

快速破解网站带来的大量文章采集器每日文章,无损加载,压缩包分享到个人朋友圈可以公开下载,也可以转发。

《全民文章采集器免费破解版》是最简单最智能的文章采集器,由优采云software开发,可以采集列表页文章、关键词新闻、微信等,还有定向采集指定网站文章,是一个很好的文章采集器。软件功能 1.

Universal文章采集器v3.0.8.0 绿色免费版 一些用户可能经常需要更新一些文章,而Universal文章采集器是一种可以到文章批量下载采集的工具,如果你对某个关键词文章感兴趣,或者你想批量下载。

文章采集(用过文章采集器——优采云采集器V9十一项强大的数据处理功能 )

采集交流 • 优采云 发表了文章 • 0 个评论 • 170 次浏览 • 2021-08-30 12:05

)

用过优采云采集器的朋友都知道优采云采集器是所有文章采集器中最全面的数据处理功能,因此被用户誉为最经典的采集软件,这里为你详细介绍文章采集器——优采云采集器V9 十一个强大的数据处理功能。

什么是数据处理?在优采云采集器中,数据处理是对内容页面中提取的信息数据的进一步处理,如替换、过滤等,优采云采集器可以同时添加多个操作,多个操作它是按从上到下的顺序执行的。换句话说,上一步的结果将作为下一步的参数。下面依次说明:

1、提取的内容为空:即如果提取的内容为空,则重新从原页面提取正则匹配的内容。

2、Content Replacement/Exclusion:顾名思义,就是用字符串替换采集的内容。如果需要排除,请用空字符串替换。

3、html标签过滤:过滤指定的html标签,如4、字符截取:通过开始和结束字符串截取内容

5、纯正则替换:通过强大的正则表达式进行复杂的内容替换。

6、数据转换:包括将结果由简体转换为复数、将结果由复数转换为简体、自动转换为拼音和时间校正转换

7、智能提取:包括第一张图片提取、智能提取时间、邮箱智能提取、手机号码智能提取、电话号码智能提取

8、Advanced特性:包括自动汇总、自动分词、Http请求、字符编码转换、同义词替换、空内容默认值、内容加前缀和后缀、随机插入、运行C#代码、批量内容替换、统计tags 字符串长度等一系列函数。

9、Complete list URL:将当前内容补全为URL。

10、文件下载:自动检测下载文件,可以设置下载路径和文件名样式。

11、内容过滤:一些不符合条件的记录可以通过设置内容过滤来删除或标记为不接受。

当我们采集文章拥有这十一个强大的数据处理功能后,我们就可以处理各种类型的网站,轻松将数据处理成我们需要的形式,省时省力。 优采云采集器V9,作为最全面的文章采集器,可以大大提高我们的工作效率,真正智能地为用户服务。

查看全部

文章采集(用过文章采集器——优采云采集器V9十一项强大的数据处理功能

)

用过优采云采集器的朋友都知道优采云采集器是所有文章采集器中最全面的数据处理功能,因此被用户誉为最经典的采集软件,这里为你详细介绍文章采集器——优采云采集器V9 十一个强大的数据处理功能。

什么是数据处理?在优采云采集器中,数据处理是对内容页面中提取的信息数据的进一步处理,如替换、过滤等,优采云采集器可以同时添加多个操作,多个操作它是按从上到下的顺序执行的。换句话说,上一步的结果将作为下一步的参数。下面依次说明:

1、提取的内容为空:即如果提取的内容为空,则重新从原页面提取正则匹配的内容。

2、Content Replacement/Exclusion:顾名思义,就是用字符串替换采集的内容。如果需要排除,请用空字符串替换。

3、html标签过滤:过滤指定的html标签,如4、字符截取:通过开始和结束字符串截取内容

5、纯正则替换:通过强大的正则表达式进行复杂的内容替换。

6、数据转换:包括将结果由简体转换为复数、将结果由复数转换为简体、自动转换为拼音和时间校正转换

7、智能提取:包括第一张图片提取、智能提取时间、邮箱智能提取、手机号码智能提取、电话号码智能提取

8、Advanced特性:包括自动汇总、自动分词、Http请求、字符编码转换、同义词替换、空内容默认值、内容加前缀和后缀、随机插入、运行C#代码、批量内容替换、统计tags 字符串长度等一系列函数。

9、Complete list URL:将当前内容补全为URL。

10、文件下载:自动检测下载文件,可以设置下载路径和文件名样式。

11、内容过滤:一些不符合条件的记录可以通过设置内容过滤来删除或标记为不接受。

当我们采集文章拥有这十一个强大的数据处理功能后,我们就可以处理各种类型的网站,轻松将数据处理成我们需要的形式,省时省力。 优采云采集器V9,作为最全面的文章采集器,可以大大提高我们的工作效率,真正智能地为用户服务。

文章采集(Phpcmsv9默认内置文章、图片、下载3个内容模型 )

采集交流 • 优采云 发表了文章 • 0 个评论 • 198 次浏览 • 2021-08-30 12:03

)

Phpcms v9 默认内置了三种内容模型:文章、图片和下载。我们先来看看最常见的文章采集。以采集新浪互联网频道国内滚动新闻栏目为例

1、进入后台,内容-内容发布管理-采集管理-添加采集点。 (与之前版本的Phpcms不同,采集management在模块菜单中)

2、URL 规则。 采集项目名称随便填,采集页面编码默认为GBK,具体采集页面可以查看网页源码。

URL采集,没什么大特色,通过查看你想要的采集页面的URL规则来填写。对目标页面进行分析,是一个序列URL,要获取的内容的URL在两个标签之间。没有其他干扰链接,因此无需定义必须和不得收录在 URL 中的字符。如果目标网站配置了Base,那么也必须配置。

URL采集配置结束,但是如果目标网站列表页面使用js实现上下页,或者获取的URL深度超过2级,用@很难实现采集。

3、Content 规则。 phpcms使用“[content]”作为通配符,然后设置开始和结束字符,然后过滤掉不需要的代码,实现内容的采集。分析目标页面的title标签比较规则,如图所示直接设置即可。

过滤器格式为“要过滤的内容[|]替换值”,如果删除,替换值留空。过滤规则支持正则表达式。该系统带有几个常见的标签过滤规则。新手要灵活过滤有点难度,所以新手需要先熟悉正则表达式。

按规则获取的作者规则、来源规则、时间规则。小编尝试了一个固定值,发现无法实现,即将某个标签设置为固定值。比如设置“source”为,但是采集result source标签为空。

内容规则,填写开始和结束标签,我们测试的目标页面比较干净,所以我们只需要过滤掉里面的超链接和一些无用的标签即可。

内容分页规则。如果内容页有分页,必须填写。文章这里没有分页。小编会在下图采集中介绍这个标签。

4、自定义规则,除了默认标签,还可以自定义各种标签。规则是一样的,但有一点需要注意:规则的英文名称必须填写,否则可以自定义标签。无法保存。

5、高级配置,这次可以设置下载图片、图片水印、内容分页和导入顺序。注意如果需要水印记得修改你的网站水印图片,水印存放路径:statics/images/water

6、规则设置好,提交回采集管理首页,可以先测试一下标签是否准确。

7、发布内容。如果都准确,先点击采集网址,采集文章地址会被自动过滤,重复的网址会被过滤掉。然后会弹出采集网址补全信息,点击“采集文章内容”

采集自动执行并显示采集进度。

采集完成后会自动返回采集管理首页,点击内容发布,进入采集文章列表,勾选要发布的文章,或者点击底部的全部导入.

进入发布计划选择界面,新建发布计划,选择发布栏。本次测试选择文章模块的“国内”列。您可以在新的计划页面上设置摘要自动提取、缩略图自动提取和导入。 文章 状态、标签和数据库的对应关系。其中,导入文章状态只有一个“发布”。如果站长需要状态为待审核,请先修改对应栏目的工作流程为一级审核。

在标签与数据库的对应关系中,采集标签与数据库字段是一一对应的。如果有自定义标签,找不到对应的字段,需要修改模型添加字段,再修改模板显示,比较技术要求高,不适合新手。此外,系统自带的处理功能也非常实用。

发布计划设置好后,会自动开始导入你刚刚选择的文章,下次导入就不用再构建计划了,选择已经构建好的计划即可。

查看全部

文章采集(Phpcmsv9默认内置文章、图片、下载3个内容模型

)

Phpcms v9 默认内置了三种内容模型:文章、图片和下载。我们先来看看最常见的文章采集。以采集新浪互联网频道国内滚动新闻栏目为例

1、进入后台,内容-内容发布管理-采集管理-添加采集点。 (与之前版本的Phpcms不同,采集management在模块菜单中)

2、URL 规则。 采集项目名称随便填,采集页面编码默认为GBK,具体采集页面可以查看网页源码。

URL采集,没什么大特色,通过查看你想要的采集页面的URL规则来填写。对目标页面进行分析,是一个序列URL,要获取的内容的URL在两个标签之间。没有其他干扰链接,因此无需定义必须和不得收录在 URL 中的字符。如果目标网站配置了Base,那么也必须配置。

URL采集配置结束,但是如果目标网站列表页面使用js实现上下页,或者获取的URL深度超过2级,用@很难实现采集。

3、Content 规则。 phpcms使用“[content]”作为通配符,然后设置开始和结束字符,然后过滤掉不需要的代码,实现内容的采集。分析目标页面的title标签比较规则,如图所示直接设置即可。

过滤器格式为“要过滤的内容[|]替换值”,如果删除,替换值留空。过滤规则支持正则表达式。该系统带有几个常见的标签过滤规则。新手要灵活过滤有点难度,所以新手需要先熟悉正则表达式。

按规则获取的作者规则、来源规则、时间规则。小编尝试了一个固定值,发现无法实现,即将某个标签设置为固定值。比如设置“source”为,但是采集result source标签为空。

内容规则,填写开始和结束标签,我们测试的目标页面比较干净,所以我们只需要过滤掉里面的超链接和一些无用的标签即可。

内容分页规则。如果内容页有分页,必须填写。文章这里没有分页。小编会在下图采集中介绍这个标签。

4、自定义规则,除了默认标签,还可以自定义各种标签。规则是一样的,但有一点需要注意:规则的英文名称必须填写,否则可以自定义标签。无法保存。

5、高级配置,这次可以设置下载图片、图片水印、内容分页和导入顺序。注意如果需要水印记得修改你的网站水印图片,水印存放路径:statics/images/water

6、规则设置好,提交回采集管理首页,可以先测试一下标签是否准确。

7、发布内容。如果都准确,先点击采集网址,采集文章地址会被自动过滤,重复的网址会被过滤掉。然后会弹出采集网址补全信息,点击“采集文章内容”

采集自动执行并显示采集进度。

采集完成后会自动返回采集管理首页,点击内容发布,进入采集文章列表,勾选要发布的文章,或者点击底部的全部导入.

进入发布计划选择界面,新建发布计划,选择发布栏。本次测试选择文章模块的“国内”列。您可以在新的计划页面上设置摘要自动提取、缩略图自动提取和导入。 文章 状态、标签和数据库的对应关系。其中,导入文章状态只有一个“发布”。如果站长需要状态为待审核,请先修改对应栏目的工作流程为一级审核。

在标签与数据库的对应关系中,采集标签与数据库字段是一一对应的。如果有自定义标签,找不到对应的字段,需要修改模型添加字段,再修改模板显示,比较技术要求高,不适合新手。此外,系统自带的处理功能也非常实用。

发布计划设置好后,会自动开始导入你刚刚选择的文章,下次导入就不用再构建计划了,选择已经构建好的计划即可。

文章采集(微信公众号毫无疑问可能已经有所变更前言(附下载))

采集交流 • 优采云 发表了文章 • 0 个评论 • 189 次浏览 • 2021-08-30 08:09

目前插件已上线,可直接在插件面板搜索bee采集。当前版本为4.0。以下内容可能已更改。

前言

随着自媒体的火爆,现在越来越多的人开始做“作家”,各种写作平台也琳琅满目,如微信公众号、简书、今日头条、百度百家等。谢谢对于微信这个大平台,微信公众号无疑是其中的佼佼者

和这个插件有毛线关系吗?

灵感来源

确实,同时在个人博客和第三方写作平台上写作的人并不多。因此,这个插件是针对一小群人的。我在开发时也考虑到了这一点。

开发这个插件的初衷是想搭建一个垂直的行业站点。一开始想过去复制文章微信公众号的内容,后来发现太慢效率太低了。不高,所以想着用履带爬行,但像我这样的懒人,如果不是万不得已是绝对不会造轮子的。想起以前同事分享的微信公众号文章采集实现了,于是找了这个项目来搭建环境,一切都很顺利。

如果你对爬虫感兴趣,可以去GitHub搜索“微信蜘蛛”,用go语言实现的,想法很好,因为我的网站是基于“Wordpress”构建的,所以为了方便我写了一个插件

想着一定有人需要这种功能,可能不需要像我这样大量导入文章,但就是想把公众号发的文章导入到博客里考虑到这一点,立即对这个插件的界面进行了优化,逻辑上也做了一些改动。由于是第一次开发Wordpress插件,简单的功能也花了两三天时间

特点

这个插件的基本功能是什么?

单个文章import批量导入可以选择将文章中的图片保存在本地(避免图片防盗链的情况)

需要注意的是,单个文章导入基本没有问题,但是如果是批量导入,则需要注意网络情况,尤其是博客所在服务器的网络情况位置不理想,建议拆分批量导入,尤其是选择将文章图片保存在本地,避免出现请求超时等情况。

以后会考虑支持简书等其他平台

使用

毫无疑问,将微信公众号的文章导入博客是主要功能。不过我相信这个插件能玩的远不止这个,这里我给出一些想法

公众号文章已关闭,与其他平台不同。很多作者自己不会在微信公众号文章发帖,发到别处。公众号有很多优质的文章,但只有一个公众号可以在短时间内快速填写内容。你可以把网站做成一个门户,但你可以选择一个垂直的领域

总结成一句话。

微信“太封闭”了,好好利用它

以上是关于如何利用微信公众号文章“关闭”的特性。与插件无关。插件只是提供了一个方便的快捷方式 查看全部

文章采集(微信公众号毫无疑问可能已经有所变更前言(附下载))

目前插件已上线,可直接在插件面板搜索bee采集。当前版本为4.0。以下内容可能已更改。

http://artizen.me/wp-content/u ... 0.png 300w, http://artizen.me/wp-content/u ... 1.png 768w" />

http://artizen.me/wp-content/u ... 0.png 300w, http://artizen.me/wp-content/u ... 1.png 768w" />前言

随着自媒体的火爆,现在越来越多的人开始做“作家”,各种写作平台也琳琅满目,如微信公众号、简书、今日头条、百度百家等。谢谢对于微信这个大平台,微信公众号无疑是其中的佼佼者

和这个插件有毛线关系吗?

灵感来源

确实,同时在个人博客和第三方写作平台上写作的人并不多。因此,这个插件是针对一小群人的。我在开发时也考虑到了这一点。

开发这个插件的初衷是想搭建一个垂直的行业站点。一开始想过去复制文章微信公众号的内容,后来发现太慢效率太低了。不高,所以想着用履带爬行,但像我这样的懒人,如果不是万不得已是绝对不会造轮子的。想起以前同事分享的微信公众号文章采集实现了,于是找了这个项目来搭建环境,一切都很顺利。

如果你对爬虫感兴趣,可以去GitHub搜索“微信蜘蛛”,用go语言实现的,想法很好,因为我的网站是基于“Wordpress”构建的,所以为了方便我写了一个插件

想着一定有人需要这种功能,可能不需要像我这样大量导入文章,但就是想把公众号发的文章导入到博客里考虑到这一点,立即对这个插件的界面进行了优化,逻辑上也做了一些改动。由于是第一次开发Wordpress插件,简单的功能也花了两三天时间

特点

这个插件的基本功能是什么?

单个文章import批量导入可以选择将文章中的图片保存在本地(避免图片防盗链的情况)

需要注意的是,单个文章导入基本没有问题,但是如果是批量导入,则需要注意网络情况,尤其是博客所在服务器的网络情况位置不理想,建议拆分批量导入,尤其是选择将文章图片保存在本地,避免出现请求超时等情况。

以后会考虑支持简书等其他平台

使用

毫无疑问,将微信公众号的文章导入博客是主要功能。不过我相信这个插件能玩的远不止这个,这里我给出一些想法

公众号文章已关闭,与其他平台不同。很多作者自己不会在微信公众号文章发帖,发到别处。公众号有很多优质的文章,但只有一个公众号可以在短时间内快速填写内容。你可以把网站做成一个门户,但你可以选择一个垂直的领域

总结成一句话。

微信“太封闭”了,好好利用它