抓取网页生成电子书

抓取网页生成电子书(2019独角兽企业重金招聘Python工程师标准(图)标准)

网站优化 • 优采云 发表了文章 • 0 个评论 • 178 次浏览 • 2021-10-04 17:15

2019独角兽企业重磅Python工程师招聘标准>>>

总有同学问,学了Python基础之后,不知道自己可以做些什么来提高。今天我就用一个小例子来告诉大家通过Python和爬虫可以完成什么样的小工具。

在知乎上,你一定关注过一些不错的专栏(比如Crossin的编程课堂)。但如果有一天,你最喜欢的受访者在网上被喷,你一怒之下删帖停止更新,你就看不到好内容了。虽然这是小概率事件(没有发生过),但你可以通过将关注的专栏导出到电子书来准备下雨天,这样你就可以离线阅读,而不必担心不小心删除帖子。

只需要工具和源码的可以拉到文章底部获取代码。

【最终效果】

运行程序,输入列的id,即网页地址上的路径:

之后程序会自动抓取列中的文章,并根据发布时间合并导出为pdf文件。

【实现思路】

本方案主要分为三部分:

抓取栏目文章地址列表抓取每篇文章的详细内容文章导出PDF1.抓取列表

在之前的文章爬虫必备工具中,掌握它就解决了一半的问题,介绍了如何分析网页上的请求。根据方法,我们可以使用开发者工具的Network功能,找出栏目页面的请求,获取明细列表:

https://www.zhihu.com/api/v4/c ... icles

观察返回的结果,我们发现通过next和is_end的值,可以得到下一个列表请求的地址(相当于页面向下滚动的触发效果),判断是否得到了所有的文章。

data中的id、title、url就是我们需要的数据。因为url可以用id拼出来,所以没有保存在我们的代码中。

使用 while 循环直到 文章 的所有 id 和 title 被捕获并保存在文件中。

while True:

resp = requests.get(url, headers=headers)

j = resp.json()

data = j['data']

for article in data:

# 保存id和title(略)

if j['paging']['is_end']:

break

url = j['paging']['next']

# 按 id 排序(略)

# 导入文件(略)

2. 抢 文章

有了文章的所有id/url,后面的爬取就很简单了。文章 主要内容在 Post-RichText 标签中。

处理一些文字需要花点功夫,比如原页面的图片效果,会添加noscript标签和,highlight">

url = 'https://zhuanlan.zhihu.com/p/' + id

html = requests.get(url, headers=headers).text

soup = BeautifulSoup(html, 'lxml')

content = soup.find(class_='Post-RichText').prettify()

# 对content做处理(略)

with open(file_name, 'w') as f:

f.write(content)

至此,所有的内容都已经抓取完毕,可以在本地读取了。

3. 导出 PDF

为了方便阅读,我们使用 wkhtmltopdf + pdfkit 将这些 HTML 文件打包成 PDF。

wkhtmltopdf是一个将HTML转PDF的工具,需要单独安装。详情请参阅其官方网站。

pdfkit 是为此工具打包的 Python 库,可以从 pip 安装:

pip install pdfkit

使用非常简单:

# 获取htmls文件名列表(略)

pdfkit.from_file(sorted(htmls), 'zhihu.pdf')

这样就完成了整列的导出。

不仅是知乎的栏目,几乎大部分的信息类型都是网站,通过1.抓取列表2.抓取详细内容采集数据两步。所以这段代码只要稍加修改就可以用于许多其他的网站。只是有些网站需要登录才能访问,所以需要在headers中设置cookie信息。另外,不同网站的请求接口、参数、限制都不一样,具体问题还是要具体问题具体分析。

这些爬虫的开发技巧可以在我们的爬虫实战课中学习。需要的请回复公众号中的实际爬虫

【源码获取】

获取知乎的专栏下载器源码,请在公众号(Crossin的编程课堂)回复关键字知乎

除了代码,还有本专栏打包好的PDF,欢迎阅读分享。

====

其他 文章 和回答:

欢迎搜索关注:Crossin的编程课堂

转载于: 查看全部

抓取网页生成电子书(2019独角兽企业重金招聘Python工程师标准(图)标准)

2019独角兽企业重磅Python工程师招聘标准>>>

总有同学问,学了Python基础之后,不知道自己可以做些什么来提高。今天我就用一个小例子来告诉大家通过Python和爬虫可以完成什么样的小工具。

在知乎上,你一定关注过一些不错的专栏(比如Crossin的编程课堂)。但如果有一天,你最喜欢的受访者在网上被喷,你一怒之下删帖停止更新,你就看不到好内容了。虽然这是小概率事件(没有发生过),但你可以通过将关注的专栏导出到电子书来准备下雨天,这样你就可以离线阅读,而不必担心不小心删除帖子。

只需要工具和源码的可以拉到文章底部获取代码。

【最终效果】

运行程序,输入列的id,即网页地址上的路径:

之后程序会自动抓取列中的文章,并根据发布时间合并导出为pdf文件。

【实现思路】

本方案主要分为三部分:

抓取栏目文章地址列表抓取每篇文章的详细内容文章导出PDF1.抓取列表

在之前的文章爬虫必备工具中,掌握它就解决了一半的问题,介绍了如何分析网页上的请求。根据方法,我们可以使用开发者工具的Network功能,找出栏目页面的请求,获取明细列表:

https://www.zhihu.com/api/v4/c ... icles

观察返回的结果,我们发现通过next和is_end的值,可以得到下一个列表请求的地址(相当于页面向下滚动的触发效果),判断是否得到了所有的文章。

data中的id、title、url就是我们需要的数据。因为url可以用id拼出来,所以没有保存在我们的代码中。

使用 while 循环直到 文章 的所有 id 和 title 被捕获并保存在文件中。

while True:

resp = requests.get(url, headers=headers)

j = resp.json()

data = j['data']

for article in data:

# 保存id和title(略)

if j['paging']['is_end']:

break

url = j['paging']['next']

# 按 id 排序(略)

# 导入文件(略)

2. 抢 文章

有了文章的所有id/url,后面的爬取就很简单了。文章 主要内容在 Post-RichText 标签中。

处理一些文字需要花点功夫,比如原页面的图片效果,会添加noscript标签和,highlight">

url = 'https://zhuanlan.zhihu.com/p/' + id

html = requests.get(url, headers=headers).text

soup = BeautifulSoup(html, 'lxml')

content = soup.find(class_='Post-RichText').prettify()

# 对content做处理(略)

with open(file_name, 'w') as f:

f.write(content)

至此,所有的内容都已经抓取完毕,可以在本地读取了。

3. 导出 PDF

为了方便阅读,我们使用 wkhtmltopdf + pdfkit 将这些 HTML 文件打包成 PDF。

wkhtmltopdf是一个将HTML转PDF的工具,需要单独安装。详情请参阅其官方网站。

pdfkit 是为此工具打包的 Python 库,可以从 pip 安装:

pip install pdfkit

使用非常简单:

# 获取htmls文件名列表(略)

pdfkit.from_file(sorted(htmls), 'zhihu.pdf')

这样就完成了整列的导出。

不仅是知乎的栏目,几乎大部分的信息类型都是网站,通过1.抓取列表2.抓取详细内容采集数据两步。所以这段代码只要稍加修改就可以用于许多其他的网站。只是有些网站需要登录才能访问,所以需要在headers中设置cookie信息。另外,不同网站的请求接口、参数、限制都不一样,具体问题还是要具体问题具体分析。

这些爬虫的开发技巧可以在我们的爬虫实战课中学习。需要的请回复公众号中的实际爬虫

【源码获取】

获取知乎的专栏下载器源码,请在公众号(Crossin的编程课堂)回复关键字知乎

除了代码,还有本专栏打包好的PDF,欢迎阅读分享。

====

其他 文章 和回答:

欢迎搜索关注:Crossin的编程课堂

转载于:

抓取网页生成电子书(下载看kindle()的所有电子书,小编觉得挺实用)

网站优化 • 优采云 发表了文章 • 0 个评论 • 202 次浏览 • 2021-10-01 12:14

本文章将详细介绍如何用Python抓取和下载Kindle网站电子书。小编觉得很实用,分享给大家参考。我希望你读了这篇文章

用于下载和查看Kindle()所有电子书的python脚本。该程序将自动下载主页第13页上的所有电子书,并将其下载到电子书目录。程序将检测它们是否已下载

#!/usr/bin/env python

# coding=utf-8

from bs4 import BeautifulSoup

import urllib2

import socket

import re

import unicodedata

import os

from urwid.text_layout import trim_line

def download(url):

print 'starting download %s' % url

response=urllib2.urlopen(url,timeout=30)

html_data=response.read()

soup=BeautifulSoup(html_data)

print 'start to analayse---------------'

title_soup=soup.find_all(class_='yanshi_xiazai')

name_soup = soup.find_all('h2')

tag_a = title_soup[0].a.attrs['href']

tag_name= title_soup[0].a.contents

link_name = name_soup[0]

link_name = str(link_name).replace("","").replace("","")

#print tag_name[0]

#print link_name

filename = link_name+".mobi"

filename = "ebook/"+filename

print 'filename is :%s' % filename

print "downloading with urllib2 %s" % tag_a

if os.path.exists(filename):

print 'already donwload ,ignore'

else:

try:

f = urllib2.urlopen(tag_a,timeout=60)

data = f.read()

#print 'the data is %s'% data

with open(filename, "wb") as code:

code.write(data)

except Exception,e:

print e

def get_all_link(url):

print 'Starting get all the list'

response=urllib2.urlopen(url,timeout=30)

html_data=response.read()

#print html_data

soup=BeautifulSoup(html_data)

link_soup = soup.find_all('a')

#print link_soup

for each_link in link_soup:

if re.search('view',str(each_link)):

#print each_link

print each_link

print each_link.attrs['href']

download(each_link.attrs['href'])

if __name__ == '__main__':

for page in range(1,13):

url = "http://kankindle.com/simple/page/3"+str(page)

url = url.strip()

print url

get_all_link(url)

以下是如何用Python抓取和下载Kindle网站电子书。我希望以上内容能帮助你学习更多的知识。如果你认为文章很好,你可以分享给更多的人看 查看全部

抓取网页生成电子书(下载看kindle()的所有电子书,小编觉得挺实用)

本文章将详细介绍如何用Python抓取和下载Kindle网站电子书。小编觉得很实用,分享给大家参考。我希望你读了这篇文章

用于下载和查看Kindle()所有电子书的python脚本。该程序将自动下载主页第13页上的所有电子书,并将其下载到电子书目录。程序将检测它们是否已下载

#!/usr/bin/env python

# coding=utf-8

from bs4 import BeautifulSoup

import urllib2

import socket

import re

import unicodedata

import os

from urwid.text_layout import trim_line

def download(url):

print 'starting download %s' % url

response=urllib2.urlopen(url,timeout=30)

html_data=response.read()

soup=BeautifulSoup(html_data)

print 'start to analayse---------------'

title_soup=soup.find_all(class_='yanshi_xiazai')

name_soup = soup.find_all('h2')

tag_a = title_soup[0].a.attrs['href']

tag_name= title_soup[0].a.contents

link_name = name_soup[0]

link_name = str(link_name).replace("","").replace("","")

#print tag_name[0]

#print link_name

filename = link_name+".mobi"

filename = "ebook/"+filename

print 'filename is :%s' % filename

print "downloading with urllib2 %s" % tag_a

if os.path.exists(filename):

print 'already donwload ,ignore'

else:

try:

f = urllib2.urlopen(tag_a,timeout=60)

data = f.read()

#print 'the data is %s'% data

with open(filename, "wb") as code:

code.write(data)

except Exception,e:

print e

def get_all_link(url):

print 'Starting get all the list'

response=urllib2.urlopen(url,timeout=30)

html_data=response.read()

#print html_data

soup=BeautifulSoup(html_data)

link_soup = soup.find_all('a')

#print link_soup

for each_link in link_soup:

if re.search('view',str(each_link)):

#print each_link

print each_link

print each_link.attrs['href']

download(each_link.attrs['href'])

if __name__ == '__main__':

for page in range(1,13):

url = "http://kankindle.com/simple/page/3"+str(page)

url = url.strip()

print url

get_all_link(url)

以下是如何用Python抓取和下载Kindle网站电子书。我希望以上内容能帮助你学习更多的知识。如果你认为文章很好,你可以分享给更多的人看

抓取网页生成电子书(网络书籍抓取器是一款能帮助用户下载指定网页的某)

网站优化 • 优采云 发表了文章 • 0 个评论 • 198 次浏览 • 2021-10-01 12:12

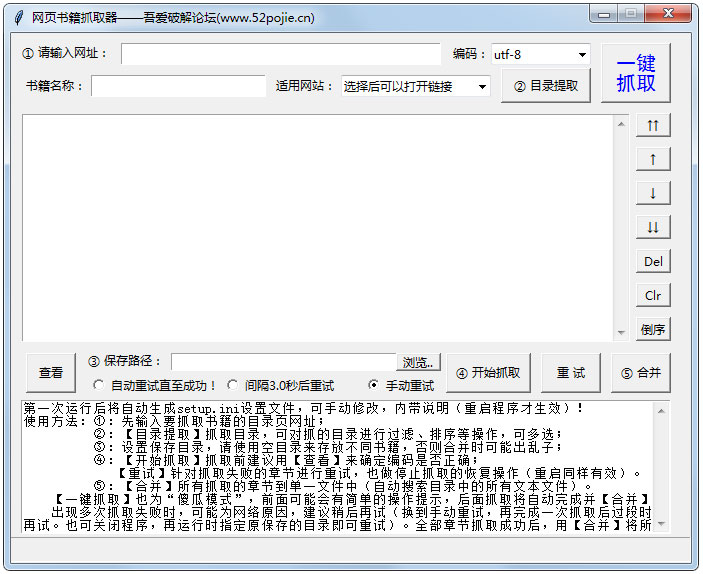

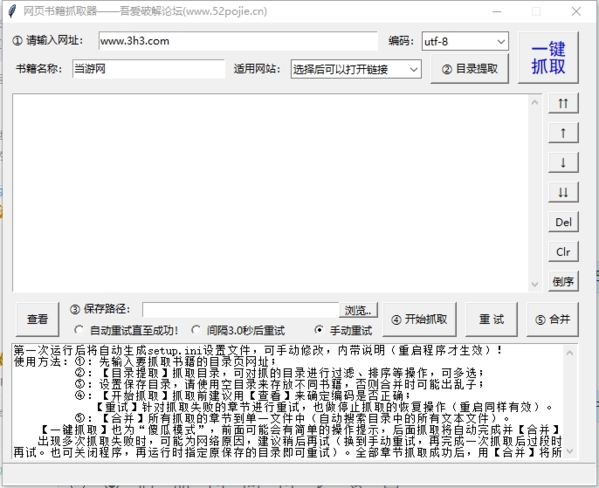

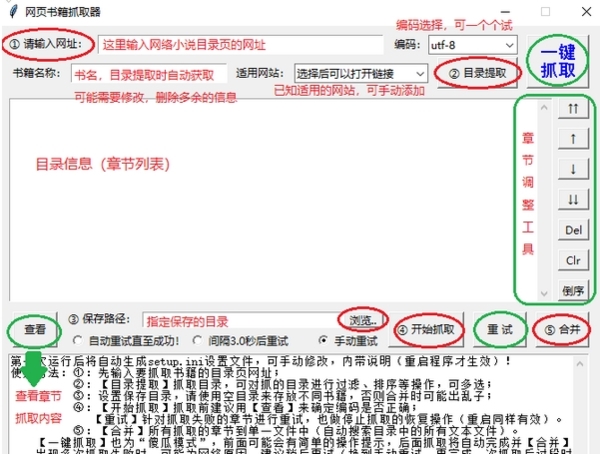

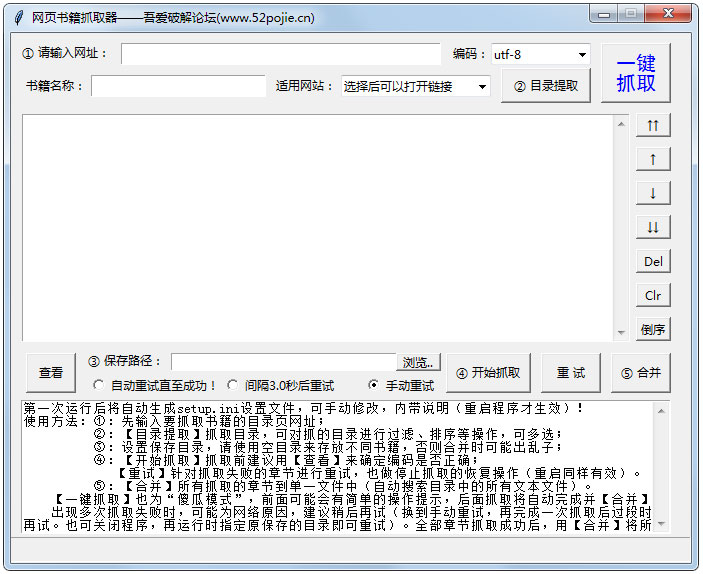

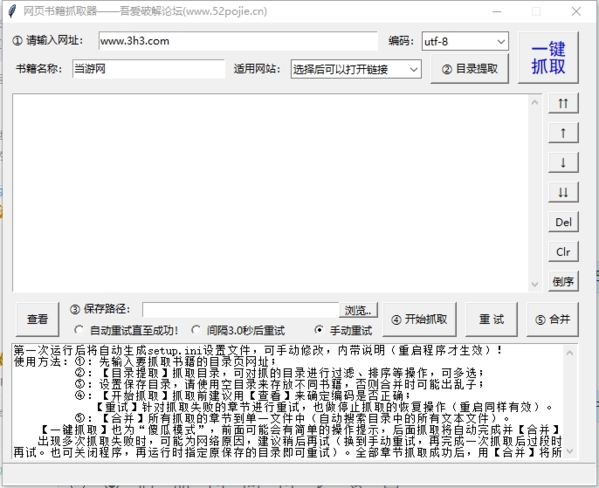

在线图书抓取器是一种可以帮助用户在指定网页上下载某本书和某章的软件。在线图书抓取器可以快速下载小说。同时软件支持断点续传功能,非常方便和需要。可以下载使用。

特征

您可以提取指定小说目录页的章节信息并进行调整,然后按照章节顺序抓取小说内容,然后以最合适的方式进行合并。抓取过程可以随时中断,关闭程序后可以继续上一个任务。

软件特点

1、 章节调整:提取目录后,可以进行移动、删除、倒序等调整操作。调整会直接影响最终的书籍,也会以调整后的章节顺序输出。

2、自动重试:在爬取过程中,由于网络因素,可能会出现爬取失败的情况。程序可能会自动重试直到成功,也可以暂时中断爬取(中断后关闭程序不影响进度),等网络好后再试。

3、停止和恢复:可以随时停止抓取过程,退出程序后不影响进度(章节信息会保存在记录中,运行程序后可以恢复抓取下一次。注意:您需要先使用停止按钮中断然后退出程序,如果直接退出,将不会恢复)。

4、 一键爬取:又称“哑模式”,基本可以实现全自动爬取合并功能,直接输出最终的文本文件。前面可能需要输入最基本的网址、保存位置等信息(会有明显的操作提示),调整章节后也可以一键抓取,抓取合并操作会自动完成.

5、适用网站:已输入10个适用网站(选择后可以快速打开网站找到您需要的书),并自动应用相应的代码, 也可以测试其他小说网站,如果一起使用,可以手动添加到设置文件中以备后用。

6、轻松制作电子书:可以在设置文件中添加每个章节名称的前缀和后缀,为后期制作电子书的目录带来极大的方便。

指示

1、首先进入你要下载的小说的网页。

2、输入书名,点击目录提取。

3、设置保存路径,点击Start crawling开始下载。 查看全部

抓取网页生成电子书(网络书籍抓取器是一款能帮助用户下载指定网页的某)

在线图书抓取器是一种可以帮助用户在指定网页上下载某本书和某章的软件。在线图书抓取器可以快速下载小说。同时软件支持断点续传功能,非常方便和需要。可以下载使用。

特征

您可以提取指定小说目录页的章节信息并进行调整,然后按照章节顺序抓取小说内容,然后以最合适的方式进行合并。抓取过程可以随时中断,关闭程序后可以继续上一个任务。

软件特点

1、 章节调整:提取目录后,可以进行移动、删除、倒序等调整操作。调整会直接影响最终的书籍,也会以调整后的章节顺序输出。

2、自动重试:在爬取过程中,由于网络因素,可能会出现爬取失败的情况。程序可能会自动重试直到成功,也可以暂时中断爬取(中断后关闭程序不影响进度),等网络好后再试。

3、停止和恢复:可以随时停止抓取过程,退出程序后不影响进度(章节信息会保存在记录中,运行程序后可以恢复抓取下一次。注意:您需要先使用停止按钮中断然后退出程序,如果直接退出,将不会恢复)。

4、 一键爬取:又称“哑模式”,基本可以实现全自动爬取合并功能,直接输出最终的文本文件。前面可能需要输入最基本的网址、保存位置等信息(会有明显的操作提示),调整章节后也可以一键抓取,抓取合并操作会自动完成.

5、适用网站:已输入10个适用网站(选择后可以快速打开网站找到您需要的书),并自动应用相应的代码, 也可以测试其他小说网站,如果一起使用,可以手动添加到设置文件中以备后用。

6、轻松制作电子书:可以在设置文件中添加每个章节名称的前缀和后缀,为后期制作电子书的目录带来极大的方便。

指示

1、首先进入你要下载的小说的网页。

2、输入书名,点击目录提取。

3、设置保存路径,点击Start crawling开始下载。

抓取网页生成电子书(一个可以帮助你快速将PDF文档中的图片、文字以及字体批量提取出来保存)

网站优化 • 优采云 发表了文章 • 0 个评论 • 160 次浏览 • 2021-10-01 12:09

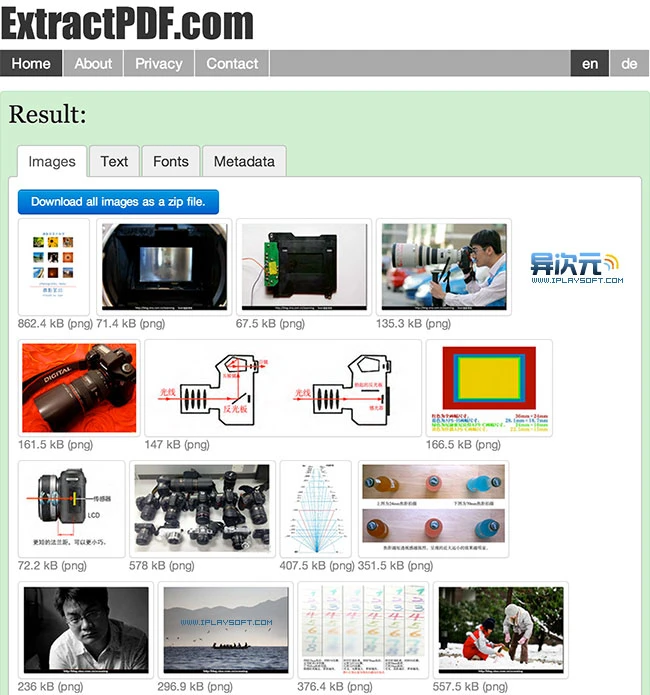

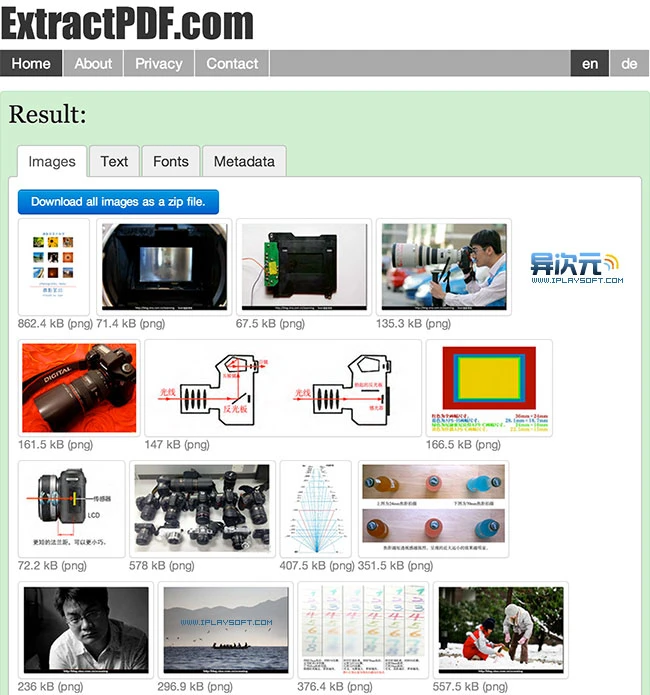

由于经常需要处理PDF文档,我一直在寻找一种快速、免费的方法,可以批量提取和保存PDF文档中的图片和文字。要实现这个功能,往往需要购买相关软件才能完成,不过现在找到了更好的方法。

它是一个网站,可以帮助您快速批量提取PDF文档中的图片、文本和嵌入字体并保存。您无需安装任何软件。您只需将 PDF 文件上传到任何计算机上的浏览器即可。网站可以导出它的所有文字和图片,使用起来非常方便。而且在测试中文PDF电子书提取时不会出现乱码问题。值得采集的工具网站……

在线导出并保存PDF文件中的图片、文字和字体网站:

的功能非常具体且完全免费。对于有这种需求的朋友来说,真是难得的好东西网站。它的用法非常简单。该页面提供了一个上传按钮。只需单击它即可上传文件。唯一的缺点是它只支持上传 10MB 以下的 PDF 文件。如果你经常需要处理大文件,那么这个工具就不是那么完美了。但是,它也可以通过网站远程下载。不知道这个功能会不会有大小限制,大家可以试试。

之前试过上传不同维度推荐给大家的《摄影笔记》PDF进行测试,图片和文字都可以正常提交。点击蓝色下载按钮进行打包下载。

导出文本的功能有时候很有用,你懂的。对中文文档的支持非常友好。试了一堆电子书,可以成功提取文字,没有乱码。

相关网址:

访问|更多Office相关|来自不同维度|更多PDF相关|更多网站推荐 查看全部

抓取网页生成电子书(一个可以帮助你快速将PDF文档中的图片、文字以及字体批量提取出来保存)

由于经常需要处理PDF文档,我一直在寻找一种快速、免费的方法,可以批量提取和保存PDF文档中的图片和文字。要实现这个功能,往往需要购买相关软件才能完成,不过现在找到了更好的方法。

它是一个网站,可以帮助您快速批量提取PDF文档中的图片、文本和嵌入字体并保存。您无需安装任何软件。您只需将 PDF 文件上传到任何计算机上的浏览器即可。网站可以导出它的所有文字和图片,使用起来非常方便。而且在测试中文PDF电子书提取时不会出现乱码问题。值得采集的工具网站……

在线导出并保存PDF文件中的图片、文字和字体网站:

的功能非常具体且完全免费。对于有这种需求的朋友来说,真是难得的好东西网站。它的用法非常简单。该页面提供了一个上传按钮。只需单击它即可上传文件。唯一的缺点是它只支持上传 10MB 以下的 PDF 文件。如果你经常需要处理大文件,那么这个工具就不是那么完美了。但是,它也可以通过网站远程下载。不知道这个功能会不会有大小限制,大家可以试试。

之前试过上传不同维度推荐给大家的《摄影笔记》PDF进行测试,图片和文字都可以正常提交。点击蓝色下载按钮进行打包下载。

导出文本的功能有时候很有用,你懂的。对中文文档的支持非常友好。试了一堆电子书,可以成功提取文字,没有乱码。

相关网址:

访问|更多Office相关|来自不同维度|更多PDF相关|更多网站推荐

抓取网页生成电子书(Windows,OSX及Linux操作系统或mobi格式的在线阅读)

网站优化 • 优采云 发表了文章 • 0 个评论 • 139 次浏览 • 2021-09-28 02:12

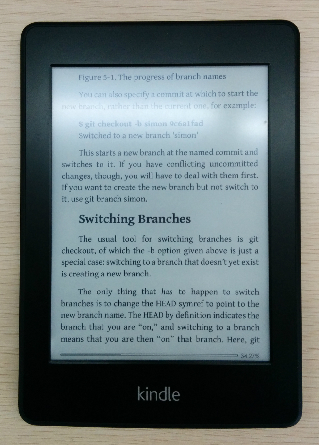

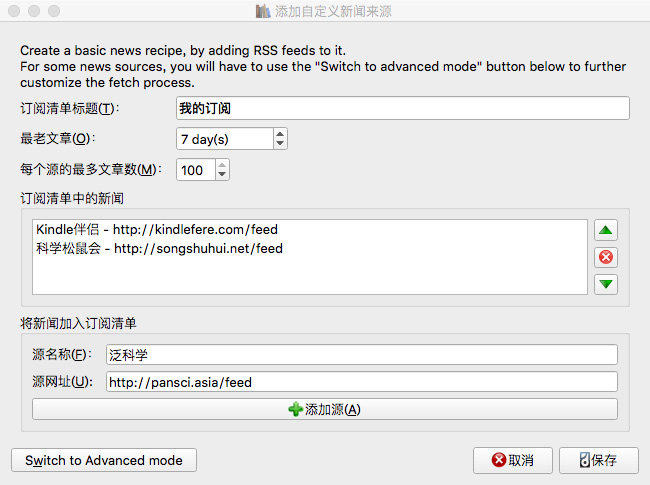

自从我买了kindle,我就一直在想如何最大限度地发挥它的功效。虽然可供购买的书籍很多,网上也有很多免费的电子书,但还是有很多网页形式的有趣内容。例如,O'Reilly Atlas 提供了很多电子书,但只提供免费在线阅读;此外,许多材料或文件只是网络形式。所以我希望将这些网上资料以某种方式转换成epub或者mobi格式,以便在kindle上阅读。本文文章介绍了如何使用calibre并编写少量代码来实现这一目标。

Calibre 简介

Calibre 是一款免费的电子书管理工具,兼容 Windows、OS X 和 Linux。令人欣慰的是,除了GUI,calibre 还提供了很多命令行工具。ebook-convert 命令可以基于用户编写的食谱。该文件(实际上是python代码)抓取指定页面的内容,生成mobi等格式的电子书。爬取行为可以通过编写recipe来定制,以适应不同的网页结构。

安装口径

Calibre的下载地址是,您可以根据自己的操作系统下载相应的安装程序。

如果是Linux操作系统,也可以通过软件仓库安装:

Archlinux:

pacman -S calibre

Debian/Ubuntu:

apt-get install calibre

红帽/Fedora/CentOS:

yum -y install calibre

请注意,如果您使用 OSX,则需要单独安装命令行工具。

抓取网页以生成电子书

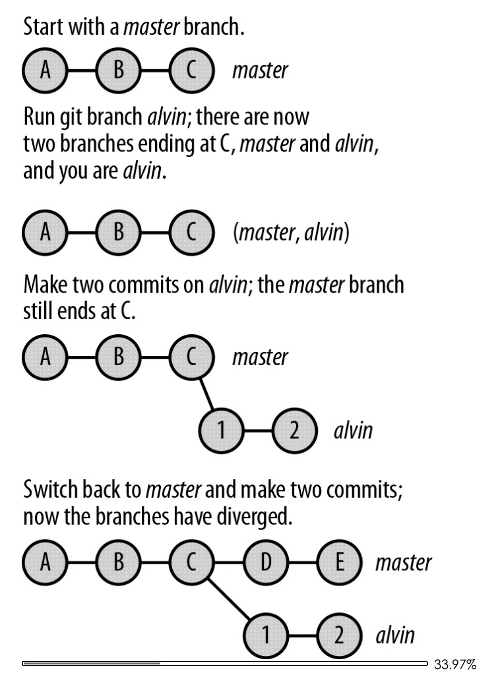

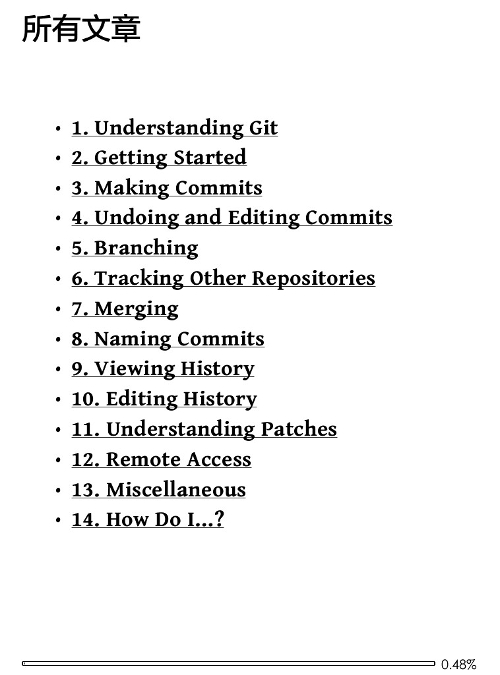

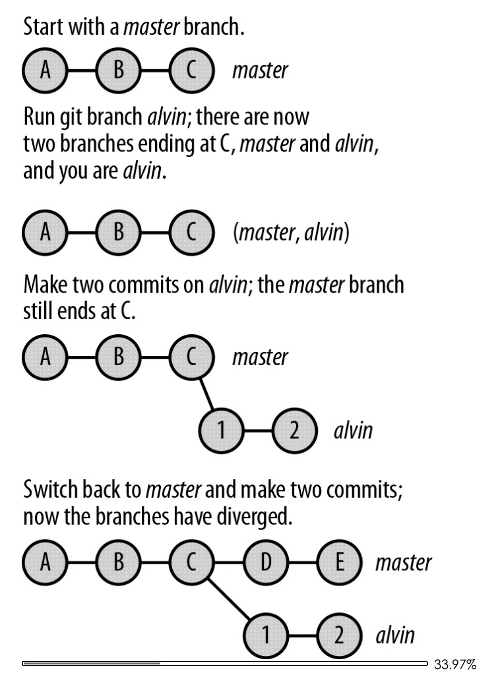

下面以Git Pocket Guide为例,说明如何通过calibre从网页生成电子书。

找到索引页

要爬取整本书,首先要找到索引页。这个页面通常是目录,也就是目录页面,其中每个目录链接都连接到相应的内容页面。在生成电子书时,索引页会指导抓取哪些页面以及内容组织的顺序。在这个例子中,索引页是。

写食谱

食谱是一个带有食谱扩展名的脚本。内容其实是一段python代码,定义了calibre爬取页面的范围和行为。以下是爬取 Git Pocket Guide 的秘籍:

from calibre.web.feeds.recipes import BasicNewsRecipe

class Git_Pocket_Guide(BasicNewsRecipe):

title = 'Git Pocket Guide'

description = ''

cover_url = 'http://akamaicovers.oreilly.co ... 39%3B

url_prefix = 'http://chimera.labs.oreilly.co ... 39%3B

no_stylesheets = True

keep_only_tags = [{ 'class': 'chapter' }]

def get_title(self, link):

return link.contents[0].strip()

def parse_index(self):

soup = self.index_to_soup(self.url_prefix + 'index.html')

div = soup.find('div', { 'class': 'toc' })

articles = []

for link in div.findAll('a'):

if '#' in link['href']:

continue

if not 'ch' in link['href']:

continue

til = self.get_title(link)

url = self.url_prefix + link['href']

a = { 'title': til, 'url': url }

articles.append(a)

ans = [('Git_Pocket_Guide', articles)]

return ans

下面解释了代码的不同部分。

整体结构

总的来说,一个recipe是一个python类,但是这个类必须继承calibre.web.feeds.recipes.BasicNewsRecipe。

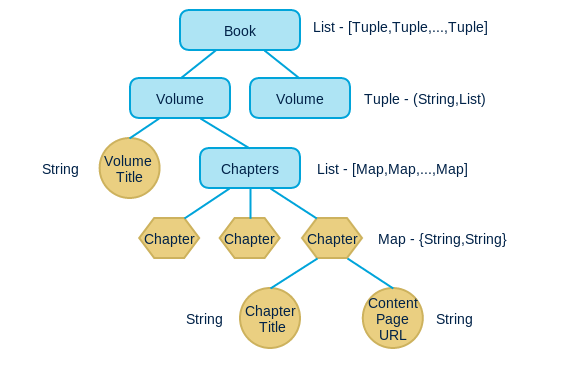

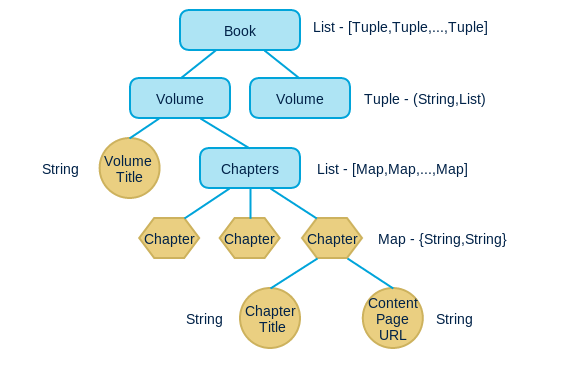

解析索引

整个recipe的核心方法是parse_index,这也是recipes必须实现的唯一方法。该方法的目标是通过分析索引页的内容,返回一个稍微复杂一些的数据结构(稍后介绍)。这个数据结构定义了整个电子书的内容和内容组织顺序。

整体属性设置

在类的开头,定义了一些全局属性:

title = 'Git Pocket Guide'

description = ''

cover_url = 'http://akamaicovers.oreilly.co ... 39%3B

url_prefix = 'http://chimera.labs.oreilly.co ... 39%3B

no_stylesheets = True

keep_only_tags = [{ 'class': 'chapter' }]

parse_index 返回值

下面通过分析索引页来描述parse_index需要返回的数据结构。

整体的返回数据结构是一个列表,其中每个元素是一个元组,一个元组代表一个卷。在这个例子中,只有一个卷,所以列表中只有一个元组。

每个元组有两个元素,第一个元素是卷名,第二个元素是一个列表,列表中的每个元素都是一个映射,表示一个章节(chapter),映射中有两个元素: title 和 url , Title是章节的标题,url是章节所在的内容页面的url。

Calibre 会根据parse_index 的返回结果对整本书进行爬取和组织,并会自行爬取处理内容内外的图片。

整个parse_index使用soup解析索引页,生成上述数据结构。

更多的

以上是最基本的食谱。如果想了解更多使用方法,可以参考API文档。

生成手机

写好菜谱后,可以在命令行中使用以下命令生成电子书:

ebook-convert Git_Pocket_Guide.recipe Git_Pocket_Guide.mobi

您可以生成mobi 格式的电子书。ebook-convert 会爬取相关内容,根据配方代码自行组织结构。

最终效果

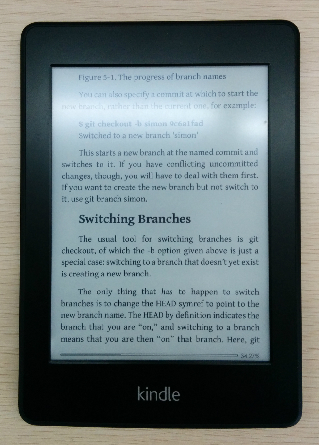

下面是在kindle上看到的效果。

内容

内容一

内容二

带图片的页面

实际效果

我的食谱仓库

我在 github 上构建了一个 kindle-open-books,其中收录一些食谱,这些食谱是我写的和其他学生贡献的。欢迎任何人提供食谱。 查看全部

抓取网页生成电子书(Windows,OSX及Linux操作系统或mobi格式的在线阅读)

自从我买了kindle,我就一直在想如何最大限度地发挥它的功效。虽然可供购买的书籍很多,网上也有很多免费的电子书,但还是有很多网页形式的有趣内容。例如,O'Reilly Atlas 提供了很多电子书,但只提供免费在线阅读;此外,许多材料或文件只是网络形式。所以我希望将这些网上资料以某种方式转换成epub或者mobi格式,以便在kindle上阅读。本文文章介绍了如何使用calibre并编写少量代码来实现这一目标。

Calibre 简介

Calibre 是一款免费的电子书管理工具,兼容 Windows、OS X 和 Linux。令人欣慰的是,除了GUI,calibre 还提供了很多命令行工具。ebook-convert 命令可以基于用户编写的食谱。该文件(实际上是python代码)抓取指定页面的内容,生成mobi等格式的电子书。爬取行为可以通过编写recipe来定制,以适应不同的网页结构。

安装口径

Calibre的下载地址是,您可以根据自己的操作系统下载相应的安装程序。

如果是Linux操作系统,也可以通过软件仓库安装:

Archlinux:

pacman -S calibre

Debian/Ubuntu:

apt-get install calibre

红帽/Fedora/CentOS:

yum -y install calibre

请注意,如果您使用 OSX,则需要单独安装命令行工具。

抓取网页以生成电子书

下面以Git Pocket Guide为例,说明如何通过calibre从网页生成电子书。

找到索引页

要爬取整本书,首先要找到索引页。这个页面通常是目录,也就是目录页面,其中每个目录链接都连接到相应的内容页面。在生成电子书时,索引页会指导抓取哪些页面以及内容组织的顺序。在这个例子中,索引页是。

写食谱

食谱是一个带有食谱扩展名的脚本。内容其实是一段python代码,定义了calibre爬取页面的范围和行为。以下是爬取 Git Pocket Guide 的秘籍:

from calibre.web.feeds.recipes import BasicNewsRecipe

class Git_Pocket_Guide(BasicNewsRecipe):

title = 'Git Pocket Guide'

description = ''

cover_url = 'http://akamaicovers.oreilly.co ... 39%3B

url_prefix = 'http://chimera.labs.oreilly.co ... 39%3B

no_stylesheets = True

keep_only_tags = [{ 'class': 'chapter' }]

def get_title(self, link):

return link.contents[0].strip()

def parse_index(self):

soup = self.index_to_soup(self.url_prefix + 'index.html')

div = soup.find('div', { 'class': 'toc' })

articles = []

for link in div.findAll('a'):

if '#' in link['href']:

continue

if not 'ch' in link['href']:

continue

til = self.get_title(link)

url = self.url_prefix + link['href']

a = { 'title': til, 'url': url }

articles.append(a)

ans = [('Git_Pocket_Guide', articles)]

return ans

下面解释了代码的不同部分。

整体结构

总的来说,一个recipe是一个python类,但是这个类必须继承calibre.web.feeds.recipes.BasicNewsRecipe。

解析索引

整个recipe的核心方法是parse_index,这也是recipes必须实现的唯一方法。该方法的目标是通过分析索引页的内容,返回一个稍微复杂一些的数据结构(稍后介绍)。这个数据结构定义了整个电子书的内容和内容组织顺序。

整体属性设置

在类的开头,定义了一些全局属性:

title = 'Git Pocket Guide'

description = ''

cover_url = 'http://akamaicovers.oreilly.co ... 39%3B

url_prefix = 'http://chimera.labs.oreilly.co ... 39%3B

no_stylesheets = True

keep_only_tags = [{ 'class': 'chapter' }]

parse_index 返回值

下面通过分析索引页来描述parse_index需要返回的数据结构。

整体的返回数据结构是一个列表,其中每个元素是一个元组,一个元组代表一个卷。在这个例子中,只有一个卷,所以列表中只有一个元组。

每个元组有两个元素,第一个元素是卷名,第二个元素是一个列表,列表中的每个元素都是一个映射,表示一个章节(chapter),映射中有两个元素: title 和 url , Title是章节的标题,url是章节所在的内容页面的url。

Calibre 会根据parse_index 的返回结果对整本书进行爬取和组织,并会自行爬取处理内容内外的图片。

整个parse_index使用soup解析索引页,生成上述数据结构。

更多的

以上是最基本的食谱。如果想了解更多使用方法,可以参考API文档。

生成手机

写好菜谱后,可以在命令行中使用以下命令生成电子书:

ebook-convert Git_Pocket_Guide.recipe Git_Pocket_Guide.mobi

您可以生成mobi 格式的电子书。ebook-convert 会爬取相关内容,根据配方代码自行组织结构。

最终效果

下面是在kindle上看到的效果。

内容

内容一

内容二

带图片的页面

实际效果

我的食谱仓库

我在 github 上构建了一个 kindle-open-books,其中收录一些食谱,这些食谱是我写的和其他学生贡献的。欢迎任何人提供食谱。

抓取网页生成电子书(网页书籍下载器是一款能帮助用户下载指定网页的某本书)

网站优化 • 优采云 发表了文章 • 0 个评论 • 136 次浏览 • 2021-09-27 10:17

网络图书下载器是一个文本下载工具。用户可以直接到小说网站、文学网站等,直接把感兴趣的书的网址复制到软件中,然后自定义书名上传网页直接下载文字到本地。

软件介绍

在线图书抓取器是一种可以帮助用户下载指定网页的某本书和某章节的软件。在线图书抓取器可以快速下载小说。同时软件支持断点续传功能,非常方便,很有必要。可以下载使用。

您可以提取指定小说目录页的章节信息并进行调整,然后按照章节顺序抓取小说内容,然后以最合适的方式进行合并。抓取过程可以随时中断,关闭程序后可以继续上一个任务。

软件特点

1、 章节调整:提取目录后,可以进行移动、删除、倒序等调整操作。调整会直接影响最终的书籍,也会以调整后的章节顺序输出。

2、自动重试:在爬取过程中,由于网络因素,可能会出现爬取失败的情况。程序可能会自动重试直到成功,也可以暂时中断爬取(中断后关闭程序不影响进度),等网络好后再试。

3、停止和恢复:可以随时停止抓取过程,退出程序后不影响进度(章节信息会保存在记录中,运行程序后可以恢复抓取下一次。注意:您需要先使用停止按钮中断然后退出程序,如果直接退出,将不会恢复)。

4、 一键抓取:又称“哑模式”,基本可以实现自动抓取合并功能,直接输出最终的文本文件。前面可能需要输入最基本的网址、保存位置等信息(会有明显的操作提示),调整章节后也可以一键抓取,抓取合并操作会自动完成.

5、适用网站:已收录10个适用网站(选择后可以快速打开网站找到您需要的书),并自动应用相应的代码,也可以测试其他小说网站,如果一起使用,可以手动添加到设置文件中,以备后用。

6、 制作电子书方便:可以在设置文件中添加每个章节名称的前缀和后缀,为后期制作电子书的目录带来极大的方便。

指示

一、首先进入你要下载的小说的网页。

二、输入书名,点击目录提取。

三、设置保存路径,点击Start crawling开始下载。 查看全部

抓取网页生成电子书(网页书籍下载器是一款能帮助用户下载指定网页的某本书)

网络图书下载器是一个文本下载工具。用户可以直接到小说网站、文学网站等,直接把感兴趣的书的网址复制到软件中,然后自定义书名上传网页直接下载文字到本地。

软件介绍

在线图书抓取器是一种可以帮助用户下载指定网页的某本书和某章节的软件。在线图书抓取器可以快速下载小说。同时软件支持断点续传功能,非常方便,很有必要。可以下载使用。

您可以提取指定小说目录页的章节信息并进行调整,然后按照章节顺序抓取小说内容,然后以最合适的方式进行合并。抓取过程可以随时中断,关闭程序后可以继续上一个任务。

软件特点

1、 章节调整:提取目录后,可以进行移动、删除、倒序等调整操作。调整会直接影响最终的书籍,也会以调整后的章节顺序输出。

2、自动重试:在爬取过程中,由于网络因素,可能会出现爬取失败的情况。程序可能会自动重试直到成功,也可以暂时中断爬取(中断后关闭程序不影响进度),等网络好后再试。

3、停止和恢复:可以随时停止抓取过程,退出程序后不影响进度(章节信息会保存在记录中,运行程序后可以恢复抓取下一次。注意:您需要先使用停止按钮中断然后退出程序,如果直接退出,将不会恢复)。

4、 一键抓取:又称“哑模式”,基本可以实现自动抓取合并功能,直接输出最终的文本文件。前面可能需要输入最基本的网址、保存位置等信息(会有明显的操作提示),调整章节后也可以一键抓取,抓取合并操作会自动完成.

5、适用网站:已收录10个适用网站(选择后可以快速打开网站找到您需要的书),并自动应用相应的代码,也可以测试其他小说网站,如果一起使用,可以手动添加到设置文件中,以备后用。

6、 制作电子书方便:可以在设置文件中添加每个章节名称的前缀和后缀,为后期制作电子书的目录带来极大的方便。

指示

一、首先进入你要下载的小说的网页。

二、输入书名,点击目录提取。

三、设置保存路径,点击Start crawling开始下载。

抓取网页生成电子书(问题的话()设置网站RSS输出方式)

网站优化 • 优采云 发表了文章 • 0 个评论 • 223 次浏览 • 2021-09-27 10:08

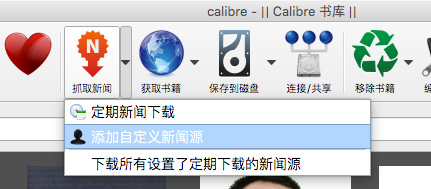

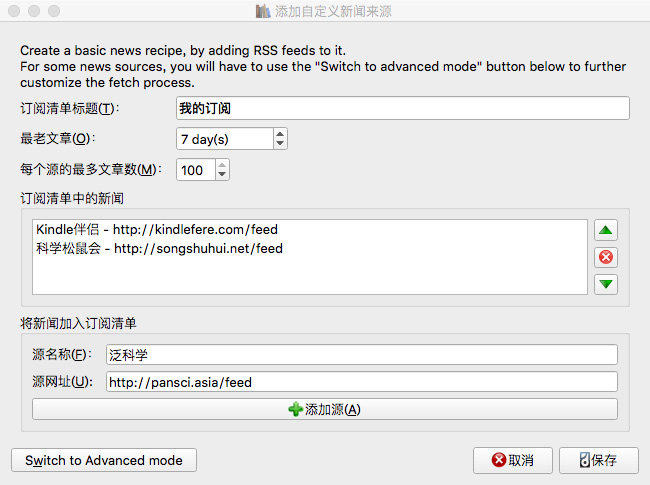

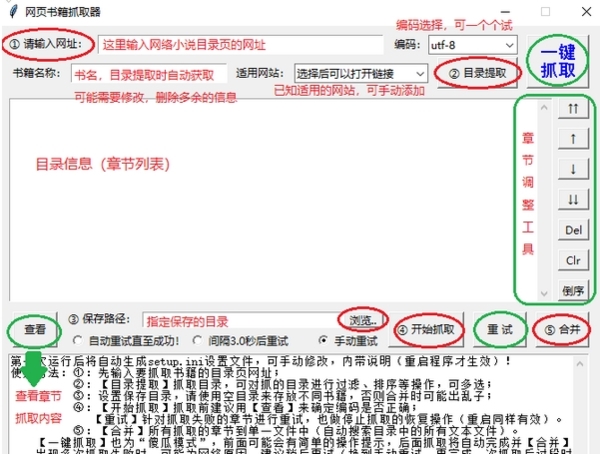

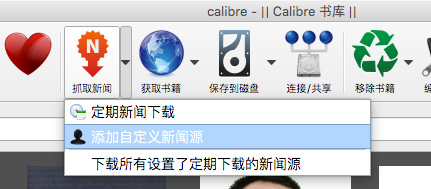

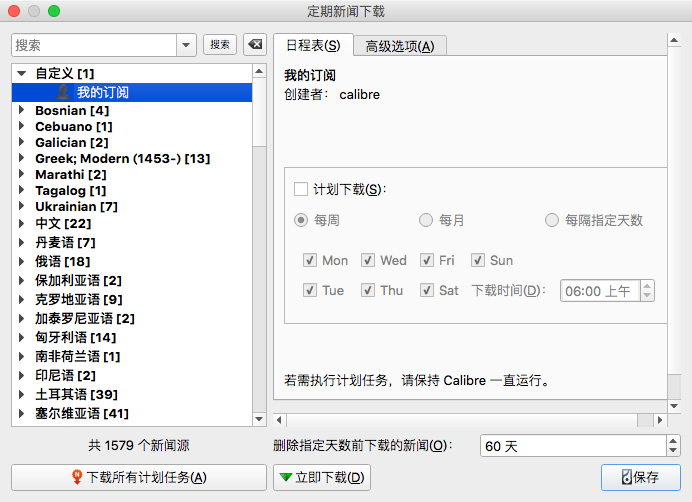

准备好 RSS 提要后,您可以在 Calibre 中添加这些提要。打开Calibre,在Calibre主界面顶部的功能图标中找到“抓取新闻”,点击右侧的向下箭头,在弹出的菜单中点击“添加自定义新闻源”。

在弹出的对话框中,点击【新建配方】按钮,切换到“添加自定义新闻源”对话框。在“订阅列表标题”中输入名称,例如“我的订阅”(此名称为类别名称,将收录一组RSS订阅地址)。

“Oldest 文章”可以设置爬取文章的时效。默认情况下,Calibre 只会在过去 7 天内抓取 文章。如果想爬更多,可以自定义更改天数。“每个源文章的最大数量”可以设置文章被爬取的数量上限。不过需要注意的是,这两个设置都受限于网站 RSS 输出方式。比如有的网站 RSS只输出有限数量的最新文章文章,所以无论怎样在Calibre中设置都会受到这个限制,你可能无法得到指定数量的文章;

接下来,您需要在“添加新闻订阅”中添加我们准保留的RSS地址。在“来源名称”中输入RSS订阅的名称,如“Kindle Companion”;然后在“来源网址”中输入RSS地址,如“”;最后点击【添加源】按钮,在“订阅列表中的新闻”中添加一个RSS订阅。您可以在一个订阅列表中抓取多个RSS提要,这样就可以重复输入多个RSS提要名称和来源URL的操作并多次添加它们。

添加RSS订阅地址后。点击右下角的【保存】按钮保存并返回“添加自定义新闻源”界面。如需修改,可以在左侧列表中选择一项,然后点击【编辑此菜谱】按钮进行修改。如需修改,点击【删除此配方】按钮即可删除。如果没有问题,可以点击【关闭】按钮,返回Calibre主界面。

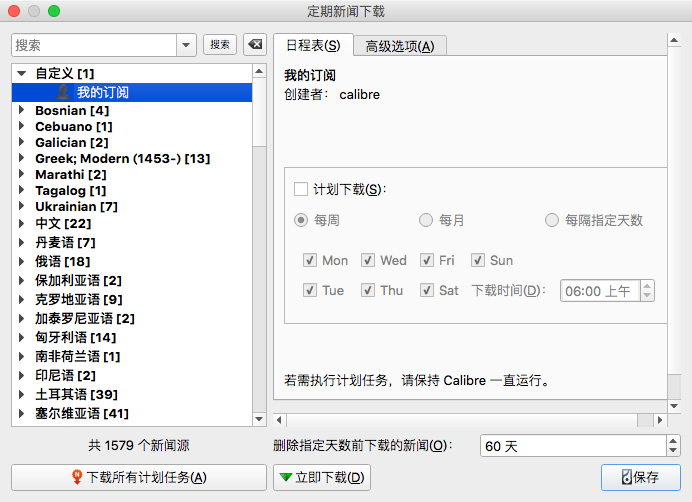

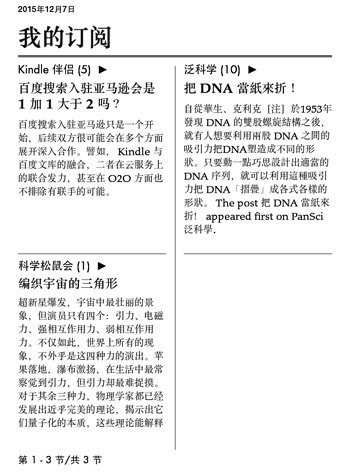

三、 抓取并推送

设置提要后,您可以获取新闻。同样,在Calibre主界面顶部的功能图标中找到“抓取新闻”,点击它,会弹出“常规新闻下载”对话框。在左侧列表中找到“自定义”类别,点击展开,即可找到刚刚添加的订阅列表。选中后,点击界面下方的【立即下载】按钮,Calibre就会开始抓取RSS内容。

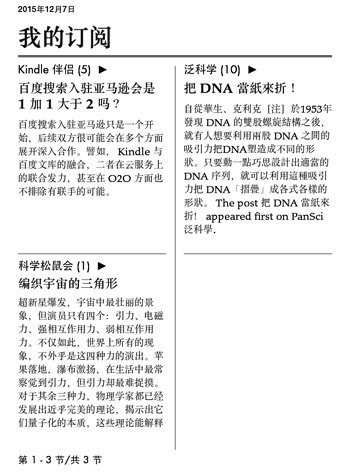

抓取成功后,Calibre 会生成一本期刊格式的电子书,并自动存入图书馆。如果您设置了邮件推送,Calibre 还会自动将生成的电子书推送到云端,自动同步到您的 Kindle。

当然,除了这种手动爬取的方式,你也可以通过“定时下载”的方式定时爬取,比如每周、每月、或者每隔指定天数爬取RSS内容,但前提是你要保持电脑开机并保持计算机连接到 Internet。

还要注意一些网站 RSS只输出摘要,所以Calibre只能抓取摘要内容;此外,如果您订阅的 RSS 被阻止并且您的网络没有使用代理,它将无法成功抓取。 查看全部

抓取网页生成电子书(问题的话()设置网站RSS输出方式)

准备好 RSS 提要后,您可以在 Calibre 中添加这些提要。打开Calibre,在Calibre主界面顶部的功能图标中找到“抓取新闻”,点击右侧的向下箭头,在弹出的菜单中点击“添加自定义新闻源”。

在弹出的对话框中,点击【新建配方】按钮,切换到“添加自定义新闻源”对话框。在“订阅列表标题”中输入名称,例如“我的订阅”(此名称为类别名称,将收录一组RSS订阅地址)。

“Oldest 文章”可以设置爬取文章的时效。默认情况下,Calibre 只会在过去 7 天内抓取 文章。如果想爬更多,可以自定义更改天数。“每个源文章的最大数量”可以设置文章被爬取的数量上限。不过需要注意的是,这两个设置都受限于网站 RSS 输出方式。比如有的网站 RSS只输出有限数量的最新文章文章,所以无论怎样在Calibre中设置都会受到这个限制,你可能无法得到指定数量的文章;

接下来,您需要在“添加新闻订阅”中添加我们准保留的RSS地址。在“来源名称”中输入RSS订阅的名称,如“Kindle Companion”;然后在“来源网址”中输入RSS地址,如“”;最后点击【添加源】按钮,在“订阅列表中的新闻”中添加一个RSS订阅。您可以在一个订阅列表中抓取多个RSS提要,这样就可以重复输入多个RSS提要名称和来源URL的操作并多次添加它们。

添加RSS订阅地址后。点击右下角的【保存】按钮保存并返回“添加自定义新闻源”界面。如需修改,可以在左侧列表中选择一项,然后点击【编辑此菜谱】按钮进行修改。如需修改,点击【删除此配方】按钮即可删除。如果没有问题,可以点击【关闭】按钮,返回Calibre主界面。

三、 抓取并推送

设置提要后,您可以获取新闻。同样,在Calibre主界面顶部的功能图标中找到“抓取新闻”,点击它,会弹出“常规新闻下载”对话框。在左侧列表中找到“自定义”类别,点击展开,即可找到刚刚添加的订阅列表。选中后,点击界面下方的【立即下载】按钮,Calibre就会开始抓取RSS内容。

抓取成功后,Calibre 会生成一本期刊格式的电子书,并自动存入图书馆。如果您设置了邮件推送,Calibre 还会自动将生成的电子书推送到云端,自动同步到您的 Kindle。

当然,除了这种手动爬取的方式,你也可以通过“定时下载”的方式定时爬取,比如每周、每月、或者每隔指定天数爬取RSS内容,但前提是你要保持电脑开机并保持计算机连接到 Internet。

还要注意一些网站 RSS只输出摘要,所以Calibre只能抓取摘要内容;此外,如果您订阅的 RSS 被阻止并且您的网络没有使用代理,它将无法成功抓取。

抓取网页生成电子书(网络书籍抓取器是一款强大的小说下载工具,使用这款工具)

网站优化 • 优采云 发表了文章 • 0 个评论 • 436 次浏览 • 2021-09-27 10:08

在线图书抓取器是一款功能强大的小说下载工具。借助此工具,用户可以从20多个小说平台抓取海量小说内容,并根据小说章节进行保存;对于需要制作电子书的用户来说,确实是一款方便易用的小说下载工具;本软件界面比较简洁,但也非常直观,为用户标明了操作步骤,按照步骤进行设置,使用本软件方便;有很多用户移动小说的时候,往往不是那么顺利,需要开通各种会员。现在使用这款软件,完全不用担心这些问题,因为它支持20多部小说网站,完全可以满足用户的下载需求。

软件功能

1、章节调整

解压目录后,可以进行移动、删除、倒序等调整操作。调整会直接影响最终书,最终书会按照调整后的章节顺序输出。

2、自动重试

在抓取过程中,由于网络因素,程序可能会自动重试成功,也可以暂时中断抓取(中断后关闭程序不会影响进度),待网络良好后再重试。

3、停止并继续

爬取过程可以随时停止,退出程序后不影响进度(章节信息会保存在记录中,下次运行程序可以继续爬取)。注意:您需要使用“停止”按钮中断然后退出程序。如果直接退出,则无法恢复)。

4、一键抓拍

又称“傻瓜模式”,基本可以实现自动抓取合并的功能,直接输出最终的文本文件。您可能需要输入最基本的网址、保存位置等信息(会有明显的操作提示),也可以在调整章节后使用一键抓取,自动完成抓取和合并操作。

5、适用网站

收录10个适用的网站(选择后可以快速打开网站找到你需要的书),并自动应用相应的代码。其他小说网站也可以测试。如果一起使用,可以手动将它们添加到设置文件中以使其待机。

6、电子书制作方便

设置文件中可以添加每章名称的前缀和后缀,为以后电子书的目录编排带来很大的方便。

软件特点

1、十余部小说免费下载网站无需注册和登录。

2、 支持四种常用的文本编码器,可以很好的解析小说内容,无乱码。

3、可以自动获取书名,一键提取书名。

4、 支持图书目录管理,可以切换目录位置,删除,排序等。

5、如果下载失败,支持会自动重试,直到下载成功。

6、下载的小说文件可以一键合并成一个文件。

指示

1、打开软件,先打开使用网站菜单,因为其他小说网站可能下载不下来,展开后选择一个网站点击即可。

2、 提示“是否在浏览器中打开”,选择“是”自动跳转打开浏览器。

3、如下图,在网站中找到你要下载的小说。

4、 点击进入小说首页,复制小说链接。

5、然后将链接粘贴到输入框中,点击“目录提取”,下面的窗口就会显示小说目录。

6、然后设置小说的输出位置,点击“开始抓取”,软件就会开始抓取短篇小说并保存到你设置的位置。

7、如下图所示,小说是按章节保存的,每章一个文本。

8、 如果保存为多个文本太复杂,可以返回软件点击“合并”。

9、 现在回到软件的输出文件夹,可以看到所有的章节已经合并为一个文本了。

10、 如果在获取目录的过程中出现乱码,可以切换“编码”,再次尝试提取。

其他相关

在线图书下载工具-在线图书抓取器下载v1.4免费版-2020年5月14日pc6下的在线图书抓取器,在线图书抓取器是一款可以帮助用户下载特定网页的工具,某本书的软件和书籍某章可通过网络抢书器快速下载小说,软件支持断点续传功能。2020年5月16日下载 网络图书抓取器主要用于抓取网络小说生成文本文件。可以帮助用户快速搜索各大平台的新奇资源,并帮助用户下载到本地电脑进行离线查看。在线抢书器可提取指定小说来源:[下载在线抢书器]在线抢书器v1.4免费版-5月16日开放,2020网络图书抓取器是一款网络图书抓取应用软件,用于从各个小说网站抓取网络小说。我们不仅可以直接抓取网站上的小说内容,还可以生成这些内容的文本,然后保存。来源:网络图书抓取器最新版本下载_网络图书抓取器2020最新版_2020年5月16日网络图书抓取器是在线图书下载的辅助工具。当您喜欢无法下载或截取的图书时,您可以在在线图书中下载到抓取器上下载,只需输入网页和图书名称即可。出处:Web Bookgrabber(在线图书下载工具)V1.5 官方版-绿色先锋 2020年5月15日 如果您需要一款好用的在线图书下载软件,你不妨试试小编带来的这款网络图书抓取器,功能强大,功能全面。使用后,它可以帮助用户更轻松、更方便地下载在线图书。

当你喜欢的来源:网络图书抓取器下载_网络图书抓取器绿色版1.4-系统首页 2020-05-14 网络图书抓取器是一个可以帮助用户下载特定网页的工具 某本书的软件和一个某些章节可以通过网络抢书器快速下载小说。同时软件支持断点续传功能,非常方便。来源:在线图书下载器-在线图书抓取器下载v1.40-凌航下载站 2020年5月14日,凌航下载站提供在线图书抓取器免费下载,是一种在线图书下载工具。你提供URL和书名,它会一键抓取,生成的目录非常完整。来源:在线图书抓取器下载-在线小说抓取软件v< @1.4 免费版-量产2020 2015年5月16日,网络图书抓取器是一款实用的网络小说抓取软件。有了它,用户可以快速提取十多部小说网站的小说章节和内容,并添加到文档中。保存在本地;本爬虫来源:网络图书抓取器下载-网络图书抓取器v1.4免费版-腾牛下载 2020-05-15 网络图书抓取器是一款免费的网络小说下载工具,可以帮助用户下载本站内容指定小说的指定章节到本地,也可以下载整本书。功能非常强大。有需要的用户不要错过来源:【网络图书抓取器】网络图书抓取器V1.4免费版官方免费版将于2020年11月12日发布, 查看全部

抓取网页生成电子书(网络书籍抓取器是一款强大的小说下载工具,使用这款工具)

在线图书抓取器是一款功能强大的小说下载工具。借助此工具,用户可以从20多个小说平台抓取海量小说内容,并根据小说章节进行保存;对于需要制作电子书的用户来说,确实是一款方便易用的小说下载工具;本软件界面比较简洁,但也非常直观,为用户标明了操作步骤,按照步骤进行设置,使用本软件方便;有很多用户移动小说的时候,往往不是那么顺利,需要开通各种会员。现在使用这款软件,完全不用担心这些问题,因为它支持20多部小说网站,完全可以满足用户的下载需求。

软件功能

1、章节调整

解压目录后,可以进行移动、删除、倒序等调整操作。调整会直接影响最终书,最终书会按照调整后的章节顺序输出。

2、自动重试

在抓取过程中,由于网络因素,程序可能会自动重试成功,也可以暂时中断抓取(中断后关闭程序不会影响进度),待网络良好后再重试。

3、停止并继续

爬取过程可以随时停止,退出程序后不影响进度(章节信息会保存在记录中,下次运行程序可以继续爬取)。注意:您需要使用“停止”按钮中断然后退出程序。如果直接退出,则无法恢复)。

4、一键抓拍

又称“傻瓜模式”,基本可以实现自动抓取合并的功能,直接输出最终的文本文件。您可能需要输入最基本的网址、保存位置等信息(会有明显的操作提示),也可以在调整章节后使用一键抓取,自动完成抓取和合并操作。

5、适用网站

收录10个适用的网站(选择后可以快速打开网站找到你需要的书),并自动应用相应的代码。其他小说网站也可以测试。如果一起使用,可以手动将它们添加到设置文件中以使其待机。

6、电子书制作方便

设置文件中可以添加每章名称的前缀和后缀,为以后电子书的目录编排带来很大的方便。

软件特点

1、十余部小说免费下载网站无需注册和登录。

2、 支持四种常用的文本编码器,可以很好的解析小说内容,无乱码。

3、可以自动获取书名,一键提取书名。

4、 支持图书目录管理,可以切换目录位置,删除,排序等。

5、如果下载失败,支持会自动重试,直到下载成功。

6、下载的小说文件可以一键合并成一个文件。

指示

1、打开软件,先打开使用网站菜单,因为其他小说网站可能下载不下来,展开后选择一个网站点击即可。

2、 提示“是否在浏览器中打开”,选择“是”自动跳转打开浏览器。

3、如下图,在网站中找到你要下载的小说。

4、 点击进入小说首页,复制小说链接。

5、然后将链接粘贴到输入框中,点击“目录提取”,下面的窗口就会显示小说目录。

6、然后设置小说的输出位置,点击“开始抓取”,软件就会开始抓取短篇小说并保存到你设置的位置。

7、如下图所示,小说是按章节保存的,每章一个文本。

8、 如果保存为多个文本太复杂,可以返回软件点击“合并”。

9、 现在回到软件的输出文件夹,可以看到所有的章节已经合并为一个文本了。

10、 如果在获取目录的过程中出现乱码,可以切换“编码”,再次尝试提取。

其他相关

在线图书下载工具-在线图书抓取器下载v1.4免费版-2020年5月14日pc6下的在线图书抓取器,在线图书抓取器是一款可以帮助用户下载特定网页的工具,某本书的软件和书籍某章可通过网络抢书器快速下载小说,软件支持断点续传功能。2020年5月16日下载 网络图书抓取器主要用于抓取网络小说生成文本文件。可以帮助用户快速搜索各大平台的新奇资源,并帮助用户下载到本地电脑进行离线查看。在线抢书器可提取指定小说来源:[下载在线抢书器]在线抢书器v1.4免费版-5月16日开放,2020网络图书抓取器是一款网络图书抓取应用软件,用于从各个小说网站抓取网络小说。我们不仅可以直接抓取网站上的小说内容,还可以生成这些内容的文本,然后保存。来源:网络图书抓取器最新版本下载_网络图书抓取器2020最新版_2020年5月16日网络图书抓取器是在线图书下载的辅助工具。当您喜欢无法下载或截取的图书时,您可以在在线图书中下载到抓取器上下载,只需输入网页和图书名称即可。出处:Web Bookgrabber(在线图书下载工具)V1.5 官方版-绿色先锋 2020年5月15日 如果您需要一款好用的在线图书下载软件,你不妨试试小编带来的这款网络图书抓取器,功能强大,功能全面。使用后,它可以帮助用户更轻松、更方便地下载在线图书。

当你喜欢的来源:网络图书抓取器下载_网络图书抓取器绿色版1.4-系统首页 2020-05-14 网络图书抓取器是一个可以帮助用户下载特定网页的工具 某本书的软件和一个某些章节可以通过网络抢书器快速下载小说。同时软件支持断点续传功能,非常方便。来源:在线图书下载器-在线图书抓取器下载v1.40-凌航下载站 2020年5月14日,凌航下载站提供在线图书抓取器免费下载,是一种在线图书下载工具。你提供URL和书名,它会一键抓取,生成的目录非常完整。来源:在线图书抓取器下载-在线小说抓取软件v< @1.4 免费版-量产2020 2015年5月16日,网络图书抓取器是一款实用的网络小说抓取软件。有了它,用户可以快速提取十多部小说网站的小说章节和内容,并添加到文档中。保存在本地;本爬虫来源:网络图书抓取器下载-网络图书抓取器v1.4免费版-腾牛下载 2020-05-15 网络图书抓取器是一款免费的网络小说下载工具,可以帮助用户下载本站内容指定小说的指定章节到本地,也可以下载整本书。功能非常强大。有需要的用户不要错过来源:【网络图书抓取器】网络图书抓取器V1.4免费版官方免费版将于2020年11月12日发布,

抓取网页生成电子书(小说抓取下载工具_善肯网页TXT使用全新的正则表达式的小说下载工具)

网站优化 • 优采云 发表了文章 • 0 个评论 • 617 次浏览 • 2021-09-25 12:18

小说爬取下载工具_山垦网页TXT采集器 采用全新正则表达式小说爬取下载工具,支持将小说整章下载并保存为txt文件,并可实时预览内容,确保下载资源没有损坏或乱码。不过这个工具只支持下载小说网站的免费章节,支持原创作者。

功能模块介绍

1、规则设置:

①在规则设置窗口,直接在网站中找到一篇文章,不写任何规则。先点击实时预览,看看能不能拿到网页的源码。如果你能得到它,然后写规则。如果你不能得到它,就没有必要继续下去。

②规则设置使用正则表达式匹配内容。最好有一定的基础。如果没有基础,可以参考给出的例子。简单易学,不需要经常学习。

③设置规则时,目录页和内容页需要分开预览,也需要两个链接,一个目录页链接和一个内容页链接。

④ 关于更换,有一般更换和定制更换。目前不需要正则化,普通替换即可。需要注意的是,必须输入一个值,一个空格也可以。删除:选择整行,然后按住删除键。当内置的\n 用作替换数据时,表示换行。

⑤编码,目前只设置了GBK和UFT-8,几乎大部分网站都是这两种编码之一。

2、解析下载

①解析请按2键解析地址。按钮1目前是任性的,不想被删除,以后会开发其他功能。

②支持单章下载和全文下载。

③支持添加章节号【部分小说无章节号时可以查看】

④ 支持在线观看,但需要联网。此功能只是辅助功能,并非专业的小说阅读软件。

⑤显示下载进度和总时间,内置多线程。

3、关于软件

①其实只要.exe就够了,规则都是自己添加的,commonrule.xml中收录了常用的替换规则。网站规则在规则文件夹中。我在里面放了两条网站规则,主要是为了测试。其他网站规则可以自行添加,也可以支持开发者。

②软件未打包,c#开发,不含病毒。别担心,请不要使用它,我不会收回它。

③关于软件中跳转到论坛,我亲自测试跳转时360提示的。也可能是因为跳转的是360浏览器。不知道你会不会遇到这个问题。

④ 如果xml中的内容不清晰,请勿触摸,以免软件识别失败和错误。 查看全部

抓取网页生成电子书(小说抓取下载工具_善肯网页TXT使用全新的正则表达式的小说下载工具)

小说爬取下载工具_山垦网页TXT采集器 采用全新正则表达式小说爬取下载工具,支持将小说整章下载并保存为txt文件,并可实时预览内容,确保下载资源没有损坏或乱码。不过这个工具只支持下载小说网站的免费章节,支持原创作者。

功能模块介绍

1、规则设置:

①在规则设置窗口,直接在网站中找到一篇文章,不写任何规则。先点击实时预览,看看能不能拿到网页的源码。如果你能得到它,然后写规则。如果你不能得到它,就没有必要继续下去。

②规则设置使用正则表达式匹配内容。最好有一定的基础。如果没有基础,可以参考给出的例子。简单易学,不需要经常学习。

③设置规则时,目录页和内容页需要分开预览,也需要两个链接,一个目录页链接和一个内容页链接。

④ 关于更换,有一般更换和定制更换。目前不需要正则化,普通替换即可。需要注意的是,必须输入一个值,一个空格也可以。删除:选择整行,然后按住删除键。当内置的\n 用作替换数据时,表示换行。

⑤编码,目前只设置了GBK和UFT-8,几乎大部分网站都是这两种编码之一。

2、解析下载

①解析请按2键解析地址。按钮1目前是任性的,不想被删除,以后会开发其他功能。

②支持单章下载和全文下载。

③支持添加章节号【部分小说无章节号时可以查看】

④ 支持在线观看,但需要联网。此功能只是辅助功能,并非专业的小说阅读软件。

⑤显示下载进度和总时间,内置多线程。

3、关于软件

①其实只要.exe就够了,规则都是自己添加的,commonrule.xml中收录了常用的替换规则。网站规则在规则文件夹中。我在里面放了两条网站规则,主要是为了测试。其他网站规则可以自行添加,也可以支持开发者。

②软件未打包,c#开发,不含病毒。别担心,请不要使用它,我不会收回它。

③关于软件中跳转到论坛,我亲自测试跳转时360提示的。也可能是因为跳转的是360浏览器。不知道你会不会遇到这个问题。

④ 如果xml中的内容不清晰,请勿触摸,以免软件识别失败和错误。

抓取网页生成电子书(Github博文地址,此处更新可能不是很及时。。)

网站优化 • 优采云 发表了文章 • 0 个评论 • 120 次浏览 • 2021-09-24 08:17

Github 博文地址,这里更新可能不是很及时。1.背景

最近发现算法和数据结构掉了不少(其实大学没好好学习,囧rz)。考虑到最近的项目结构越来越复杂,就用它来实践自己的想法,打算复习一下数据结构和算法。. 结合最近的英语学习,然后自己干脆用英语。然后选择一本参考书《Java 中的数据结构和算法》。

起初,它非常费力,所以请慢慢来。因为之前有翻书的习惯,所以去书所附的官网,发现所附的PDF文件其实还不错,图文并茂。是很好的理解资料,所以要果断下载。不过,尼玛,原来还有很多。一个一个的救他们,真的很可怕。想想如何下载它们。

2.实现

考虑到目前为止你所学和理解的所有语言,可以用来实现,并将级别安排如下:

Java/Android 熟悉 C# 熟悉 Python 熟悉语法 Javascript 熟悉一些 C/C++ 熟悉语法

为了实现这一点,当然是最简单、最快和最好的。考虑到大学一直在使用C#,为什么不使用它呢?但是发现OSX平台只能使用Mono,不得不重新熟悉一下。考虑到所需的时间,Java 实现并不快。我对Javascript不熟悉,好像可以用node.js来写(atom用的)。陌生。C/C++很多年没用了,要实现的代码很多,特别麻烦。考虑到前段时间正好在Codecademy学了语法,就用它来练习吧。

好的,我肯定会使用 Python。后续就是如何请求网络,解析网页的html标签,提取下载链接,下载文件。虽然我不明白这些是如何在 Python 中实现的,但过程是确定的。按照流程到网站找一个现成的。原理这里不研究,实现功能即可。

下一步就是用各种搜索引擎搜索东西,谷歌可以,百度也可以(不同的引擎有不同的侧重点)。不要忘记目的是什么,搜索相关信息。

好的,搜索之后,一定要从网上请求网页下载请求,BeautifulSoup解析html,提取下载链接BeautifulSoup,下载文档(stackoverflow里找到了一段下载文件的代码)。

然后他们将它们组合在一起。组合后的代码如下:

1 #file-name: pdf_download.py

2 __author__ = 'rxread'

3 import requests

4 from bs4 import BeautifulSoup

5

6

7 def download_file(url, index):

8 local_filename = index+"-"+url.split('/')[-1]

9 # NOTE the stream=True parameter

10 r = requests.get(url, stream=True)

11 with open(local_filename, 'wb') as f:

12 for chunk in r.iter_content(chunk_size=1024):

13 if chunk: # filter out keep-alive new chunks

14 f.write(chunk)

15 f.flush()

16 return local_filename

17

18 #http://ww0.java4.datastructures.net/handouts/

19 root_link="http://ww0.java4.datastructure ... ot%3B

20 r=requests.get(root_link)

21 if r.status_code==200:

22 soup=BeautifulSoup(r.text)

23 # print soup.prettify()

24 index=1

25 for link in soup.find_all('a'):

26 new_link=root_link+link.get('href')

27 if new_link.endswith(".pdf"):

28 file_path=download_file(new_link,str(index))

29 print "downloading:"+new_link+" -> "+file_path

30 index+=1

31 print "all download finished"

32 else:

33 print "errors occur."

查看代码

运行以下代码将所有pdf文档下载到本地。

1 python pdf_download.py

查看代码

3.优化

30多行代码,全部搞定。它真的简洁明了。果然,用 Python 做一些脚本任务还是不错的。已使用它下载了 41 个文档。

一开始下载的文件没有序列号,看的时候不知道顺序,所以在文件名前加了一个序列号。

其他优化部分可以参考如下:

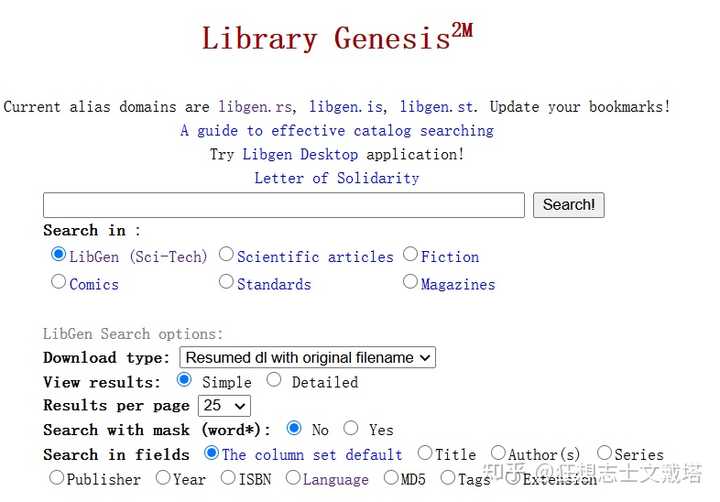

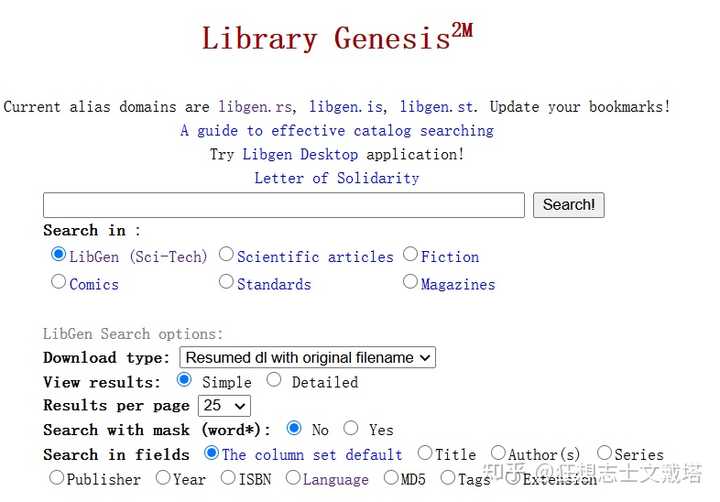

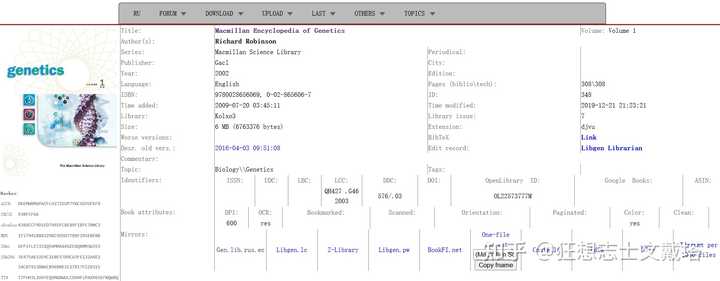

考虑到当前函数的一些异常错误没有处理,需要稍后处理。功能未完全封装,不支持下载的文件类型。这可以根据您将来的需要进行扩展。这样在下载的文件少的时候可能还好,但是如果文件多,就需要使用多线程(数量合适)或者线程池来下载,加快下载速度。有的写可能不符合python语法规范,当然写和不写的区别已经是0和1了。其他的细节,比如pdf可能是大写的PDF。4.附录“Java 中的数据结构和算法”(Michael T. Goodrich、Roberto Tamassia)下载或

下面两个网站是好书下载网站。如果可能,您应该购买正版书籍以支持作者。

一般我会先下载电子书,如果合适再买纸质版。Python 语法入门

就是这样。

本文来自RxRead的博客,欢迎转载,如转载请注明。

欢迎共同探讨。 查看全部

抓取网页生成电子书(Github博文地址,此处更新可能不是很及时。。)

Github 博文地址,这里更新可能不是很及时。1.背景

最近发现算法和数据结构掉了不少(其实大学没好好学习,囧rz)。考虑到最近的项目结构越来越复杂,就用它来实践自己的想法,打算复习一下数据结构和算法。. 结合最近的英语学习,然后自己干脆用英语。然后选择一本参考书《Java 中的数据结构和算法》。

起初,它非常费力,所以请慢慢来。因为之前有翻书的习惯,所以去书所附的官网,发现所附的PDF文件其实还不错,图文并茂。是很好的理解资料,所以要果断下载。不过,尼玛,原来还有很多。一个一个的救他们,真的很可怕。想想如何下载它们。

2.实现

考虑到目前为止你所学和理解的所有语言,可以用来实现,并将级别安排如下:

Java/Android 熟悉 C# 熟悉 Python 熟悉语法 Javascript 熟悉一些 C/C++ 熟悉语法

为了实现这一点,当然是最简单、最快和最好的。考虑到大学一直在使用C#,为什么不使用它呢?但是发现OSX平台只能使用Mono,不得不重新熟悉一下。考虑到所需的时间,Java 实现并不快。我对Javascript不熟悉,好像可以用node.js来写(atom用的)。陌生。C/C++很多年没用了,要实现的代码很多,特别麻烦。考虑到前段时间正好在Codecademy学了语法,就用它来练习吧。

好的,我肯定会使用 Python。后续就是如何请求网络,解析网页的html标签,提取下载链接,下载文件。虽然我不明白这些是如何在 Python 中实现的,但过程是确定的。按照流程到网站找一个现成的。原理这里不研究,实现功能即可。

下一步就是用各种搜索引擎搜索东西,谷歌可以,百度也可以(不同的引擎有不同的侧重点)。不要忘记目的是什么,搜索相关信息。

好的,搜索之后,一定要从网上请求网页下载请求,BeautifulSoup解析html,提取下载链接BeautifulSoup,下载文档(stackoverflow里找到了一段下载文件的代码)。

然后他们将它们组合在一起。组合后的代码如下:

1 #file-name: pdf_download.py

2 __author__ = 'rxread'

3 import requests

4 from bs4 import BeautifulSoup

5

6

7 def download_file(url, index):

8 local_filename = index+"-"+url.split('/')[-1]

9 # NOTE the stream=True parameter

10 r = requests.get(url, stream=True)

11 with open(local_filename, 'wb') as f:

12 for chunk in r.iter_content(chunk_size=1024):

13 if chunk: # filter out keep-alive new chunks

14 f.write(chunk)

15 f.flush()

16 return local_filename

17

18 #http://ww0.java4.datastructures.net/handouts/

19 root_link="http://ww0.java4.datastructure ... ot%3B

20 r=requests.get(root_link)

21 if r.status_code==200:

22 soup=BeautifulSoup(r.text)

23 # print soup.prettify()

24 index=1

25 for link in soup.find_all('a'):

26 new_link=root_link+link.get('href')

27 if new_link.endswith(".pdf"):

28 file_path=download_file(new_link,str(index))

29 print "downloading:"+new_link+" -> "+file_path

30 index+=1

31 print "all download finished"

32 else:

33 print "errors occur."

查看代码

运行以下代码将所有pdf文档下载到本地。

1 python pdf_download.py

查看代码

3.优化

30多行代码,全部搞定。它真的简洁明了。果然,用 Python 做一些脚本任务还是不错的。已使用它下载了 41 个文档。

一开始下载的文件没有序列号,看的时候不知道顺序,所以在文件名前加了一个序列号。

其他优化部分可以参考如下:

考虑到当前函数的一些异常错误没有处理,需要稍后处理。功能未完全封装,不支持下载的文件类型。这可以根据您将来的需要进行扩展。这样在下载的文件少的时候可能还好,但是如果文件多,就需要使用多线程(数量合适)或者线程池来下载,加快下载速度。有的写可能不符合python语法规范,当然写和不写的区别已经是0和1了。其他的细节,比如pdf可能是大写的PDF。4.附录“Java 中的数据结构和算法”(Michael T. Goodrich、Roberto Tamassia)下载或

下面两个网站是好书下载网站。如果可能,您应该购买正版书籍以支持作者。

一般我会先下载电子书,如果合适再买纸质版。Python 语法入门

就是这样。

本文来自RxRead的博客,欢迎转载,如转载请注明。

欢迎共同探讨。

抓取网页生成电子书(mitmdump爬取“得到”App电子书信息(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 170 次浏览 • 2021-09-24 08:16

PS:如果你需要Python学习材料,你可以点击下面的链接自己获取

Mitmdump爬网“获取”应用程序电子书信息

“获取”应用程序是由逻辑思维产生的零碎时间学习应用程序。应用程序中有许多学习资源。但是,“获取”应用程序没有相应的web版本,因此必须通过该应用程序获取信息。这次,我们通过抓取mitmdump的应用程序来练习它的用法

爬升目标

我们的目标是抓取应用程序中电子书部分的电子书信息,并将信息保存到mongodb,如图所示

我们需要把这本书的名字、介绍、封面和价格降下来。但是,此次爬升的重点是了解mitmdump工具的使用,因此暂时不涉及自动爬升。应用程序的操作仍然是手动的。Mitmdump负责捕获响应并提取和保存数据

2.准备

请确保已正确安装mitmproxy和mitmdump。手机和个人电脑在同一个局域网内。同时,配置mitmproxy的CA证书,安装mongodb并运行其服务,安装pymongo库。有关具体配置,请参阅第1章中的说明

3.抓斗分析

首先,浏览URL并返回当前页面的内容。让我们编写一个脚本,如下所示:

1 defresponse(flow):2打印(flow.request.url)3打印(flow.response.text)

这里,只输出请求的URL和响应的主体内容,也就是说,请求链接和响应内容是两个最关键的部分。脚本保存名称为script.py

接下来,运行mitmdump。命令如下:

mitmdump-s script.py

打开“获取”应用的电子书页面,可以在PC控制台上看到相应的输出。然后滑动页面以加载更多电子书。控制台的新输出内容是应用程序发送的新加载请求,包括下一页的电子书内容。控制台输出结果的示例如图所示

您可以看到带有URL的接口,URL后面跟着一个符号参数。通过URL的名称,您可以确定这是获取电子书列表的接口。URL下面的输出是响应内容,它是JSON格式的字符串。我们格式化它,如图所示

格式化内容收录一个C字段和一个列表字段。列表的每个元素都收录价格、标题、描述等。第一个返回的结果是电子书爱好者。此时,应用程序的内容也是电子书。所描述的内容和价格也完全匹配。应用程序页面如图所示

这表明当前接口是获取电子书信息的接口。我们只需要从这个界面获取内容。然后解析返回的结果并将结果保存到数据库中

4.数据捕获

接下来,我们需要过滤接口,获取上面分析的接口,然后在结果中提取相应的字段

在这里,我们修改脚本如下:

1从mitmproxy进口JSON2进口TX3

4 defresponse(flow):5 url='#39

6.ifflow.request.url.startswith(url):7 text=flow.response.text8 data=json.loads(text)9 books=data.get('c')。get('list')10图书目录:11(str(book))

再次滑动电子书页面,观察PC控制台上的输出,如图所示

控制台输出

现在这本书的所有信息都被输出了。图书信息对应于JSON格式的一段数据

5.提取保存

接下来,我们需要提取信息并将其保存到数据库中。为了方便起见,我们选择mongodb数据库

脚本还可以添加提取和保存信息的部分。修改后的代码如下:

1进口JSON2进口PMONGO3来自mitmproxy进口TX4

5 client=pymongo.MongoClient('localhost')6 db=client['igetget']7 采集=db['books']8

9 defresponse(flow):10 global采集11 url='#39

12 ifflow.request.url.startswith(url):13 text=flow.response.text14 data=json.loads(text)15 books=data.get('c').get('list')16图书入库:17 data={'title':book.get('operating_title')、18'cover':book.get('cover')、19'summary':book.get('other_share_summary')、20'price':book.get('price')21}22(str data))采集.insert(data)

再次滑动页面,控制台将输出信息,如图所示

现在每个输出都是提取的内容,包括电子书的标题、封面、描述和价格信息

一开始

,我们声明了MongoDB的数据库连接。提取信息后,我们调用对象的insert()方法将数据插入数据库。p>

滑动几页,发现所有书籍信息都保存在mongodb中,如图所示

到目前为止,我们已经使用了一个非常简单的脚本来保存“get”应用程序的电子书信息

代码部分

1进口JSON2进口PMONGO3来自mitmproxy进口TX45 client=pymongo.MongoClient('localhost')6 db=client['igetget']7 采集=db['books']8910 defresponse(flow):11 global采集12 url='#39

13 ifflow.request.url.startswith(url):14 text=flow.response.text15 data=json.loads(text)16 books=data.get('c').get('list')17图书内置:18 data={19'title':book.get('operating_title'),20'cover':book.get('cover'),21'summary':book.get('other(share)summary'),22'price':book.get('price')23}24(str data))25 采集.insert(data) 查看全部

抓取网页生成电子书(mitmdump爬取“得到”App电子书信息(组图))

PS:如果你需要Python学习材料,你可以点击下面的链接自己获取

Mitmdump爬网“获取”应用程序电子书信息

“获取”应用程序是由逻辑思维产生的零碎时间学习应用程序。应用程序中有许多学习资源。但是,“获取”应用程序没有相应的web版本,因此必须通过该应用程序获取信息。这次,我们通过抓取mitmdump的应用程序来练习它的用法

爬升目标

我们的目标是抓取应用程序中电子书部分的电子书信息,并将信息保存到mongodb,如图所示

我们需要把这本书的名字、介绍、封面和价格降下来。但是,此次爬升的重点是了解mitmdump工具的使用,因此暂时不涉及自动爬升。应用程序的操作仍然是手动的。Mitmdump负责捕获响应并提取和保存数据

2.准备

请确保已正确安装mitmproxy和mitmdump。手机和个人电脑在同一个局域网内。同时,配置mitmproxy的CA证书,安装mongodb并运行其服务,安装pymongo库。有关具体配置,请参阅第1章中的说明

3.抓斗分析

首先,浏览URL并返回当前页面的内容。让我们编写一个脚本,如下所示:

1 defresponse(flow):2打印(flow.request.url)3打印(flow.response.text)

这里,只输出请求的URL和响应的主体内容,也就是说,请求链接和响应内容是两个最关键的部分。脚本保存名称为script.py

接下来,运行mitmdump。命令如下:

mitmdump-s script.py

打开“获取”应用的电子书页面,可以在PC控制台上看到相应的输出。然后滑动页面以加载更多电子书。控制台的新输出内容是应用程序发送的新加载请求,包括下一页的电子书内容。控制台输出结果的示例如图所示

您可以看到带有URL的接口,URL后面跟着一个符号参数。通过URL的名称,您可以确定这是获取电子书列表的接口。URL下面的输出是响应内容,它是JSON格式的字符串。我们格式化它,如图所示

格式化内容收录一个C字段和一个列表字段。列表的每个元素都收录价格、标题、描述等。第一个返回的结果是电子书爱好者。此时,应用程序的内容也是电子书。所描述的内容和价格也完全匹配。应用程序页面如图所示

这表明当前接口是获取电子书信息的接口。我们只需要从这个界面获取内容。然后解析返回的结果并将结果保存到数据库中

4.数据捕获

接下来,我们需要过滤接口,获取上面分析的接口,然后在结果中提取相应的字段

在这里,我们修改脚本如下:

1从mitmproxy进口JSON2进口TX3

4 defresponse(flow):5 url='#39

6.ifflow.request.url.startswith(url):7 text=flow.response.text8 data=json.loads(text)9 books=data.get('c')。get('list')10图书目录:11(str(book))

再次滑动电子书页面,观察PC控制台上的输出,如图所示

控制台输出

现在这本书的所有信息都被输出了。图书信息对应于JSON格式的一段数据

5.提取保存

接下来,我们需要提取信息并将其保存到数据库中。为了方便起见,我们选择mongodb数据库

脚本还可以添加提取和保存信息的部分。修改后的代码如下:

1进口JSON2进口PMONGO3来自mitmproxy进口TX4

5 client=pymongo.MongoClient('localhost')6 db=client['igetget']7 采集=db['books']8

9 defresponse(flow):10 global采集11 url='#39

12 ifflow.request.url.startswith(url):13 text=flow.response.text14 data=json.loads(text)15 books=data.get('c').get('list')16图书入库:17 data={'title':book.get('operating_title')、18'cover':book.get('cover')、19'summary':book.get('other_share_summary')、20'price':book.get('price')21}22(str data))采集.insert(data)

再次滑动页面,控制台将输出信息,如图所示

现在每个输出都是提取的内容,包括电子书的标题、封面、描述和价格信息

一开始

,我们声明了MongoDB的数据库连接。提取信息后,我们调用对象的insert()方法将数据插入数据库。p>

滑动几页,发现所有书籍信息都保存在mongodb中,如图所示

到目前为止,我们已经使用了一个非常简单的脚本来保存“get”应用程序的电子书信息

代码部分

1进口JSON2进口PMONGO3来自mitmproxy进口TX45 client=pymongo.MongoClient('localhost')6 db=client['igetget']7 采集=db['books']8910 defresponse(flow):11 global采集12 url='#39

13 ifflow.request.url.startswith(url):14 text=flow.response.text15 data=json.loads(text)16 books=data.get('c').get('list')17图书内置:18 data={19'title':book.get('operating_title'),20'cover':book.get('cover'),21'summary':book.get('other(share)summary'),22'price':book.get('price')23}24(str data))25 采集.insert(data)

抓取网页生成电子书(免费制作个性化电子书的方法,你值得拥有!!)

网站优化 • 优采云 发表了文章 • 0 个评论 • 87 次浏览 • 2021-09-24 08:14

编者注(@Minja):在写文章时,经常需要引用和回溯。对各种存档和切割工具的不满,让我萌生了自己制作电子书的念头。恰巧@Spencerwoo在这方面有扎实的折腾能力,于是干掉他,研究了一套简单易行的方法,写成文章与大家分享。

虽然网络世界中有很多有价值的文章,但并不是每一次阅读体验都令人满意。如果你想拥有出色的文章阅读体验,至少我们必须保证我们正在阅读文章:

很多时候,我们依靠浏览器的阅读方式,或者Pocket和RSS客户端来阅读。但是,稍后无法对阅读模式进行排序。大多数阅读服务的全文搜索功能需要付费,网上的文章可能哪天都搜不到。或许,将文章以电子书的形式保存在本地,是一个更方便的回顾选择。

如果我们在网上看到一个网页形式的电子书,想把整个网页直接保存在本地(俗称“剪辑”),那会很麻烦。现有的网络剪辑工具不仅可能夹带无用的、影响体验的广告和其他冗余区域,而且还可能丢失重要和有价值的内容。不仅如此,几乎没有文章这样的工具可以轻松抓取图片并保存到本地。那么,让我向您介绍一套免费制作个性化电子书的方法。

本文主要使用开源工具Pandoc。对于需要MOBI或PDF格式电子书的读者,文章后半部分也有简单的转换方法。

以ePub电子书为突破口

主流的电子书格式有很多,但本文主要推荐ePub,它相对开放通用,可以轻松转换为其他格式。

主流电子书格式

最广为人知的电子书格式可能是纯文本TXT格式,但TXT之所以被称为“纯文本”,是因为它不支持章节、图片、封面和超链接。为了让电子书有格式、有图片、有内容,目前常见的电子书通常有PDF、ePub、MOBI三种格式。在:

我们文章的主要目的是利用接下来要介绍的工具,制作一个清晰美观的电子书,内嵌图片,目录,美观。相对来说ePub更加灵活,目录和自定义布局一应俱全,另外两种格式转换也方便。本文将从它开始。

电子书效果制作 查看全部

抓取网页生成电子书(免费制作个性化电子书的方法,你值得拥有!!)

编者注(@Minja):在写文章时,经常需要引用和回溯。对各种存档和切割工具的不满,让我萌生了自己制作电子书的念头。恰巧@Spencerwoo在这方面有扎实的折腾能力,于是干掉他,研究了一套简单易行的方法,写成文章与大家分享。

虽然网络世界中有很多有价值的文章,但并不是每一次阅读体验都令人满意。如果你想拥有出色的文章阅读体验,至少我们必须保证我们正在阅读文章:

很多时候,我们依靠浏览器的阅读方式,或者Pocket和RSS客户端来阅读。但是,稍后无法对阅读模式进行排序。大多数阅读服务的全文搜索功能需要付费,网上的文章可能哪天都搜不到。或许,将文章以电子书的形式保存在本地,是一个更方便的回顾选择。

如果我们在网上看到一个网页形式的电子书,想把整个网页直接保存在本地(俗称“剪辑”),那会很麻烦。现有的网络剪辑工具不仅可能夹带无用的、影响体验的广告和其他冗余区域,而且还可能丢失重要和有价值的内容。不仅如此,几乎没有文章这样的工具可以轻松抓取图片并保存到本地。那么,让我向您介绍一套免费制作个性化电子书的方法。

本文主要使用开源工具Pandoc。对于需要MOBI或PDF格式电子书的读者,文章后半部分也有简单的转换方法。

以ePub电子书为突破口

主流的电子书格式有很多,但本文主要推荐ePub,它相对开放通用,可以轻松转换为其他格式。

主流电子书格式

最广为人知的电子书格式可能是纯文本TXT格式,但TXT之所以被称为“纯文本”,是因为它不支持章节、图片、封面和超链接。为了让电子书有格式、有图片、有内容,目前常见的电子书通常有PDF、ePub、MOBI三种格式。在:

我们文章的主要目的是利用接下来要介绍的工具,制作一个清晰美观的电子书,内嵌图片,目录,美观。相对来说ePub更加灵活,目录和自定义布局一应俱全,另外两种格式转换也方便。本文将从它开始。

电子书效果制作

抓取网页生成电子书(如何从同一个Markdown源文件生成网页和ePub格式的电子书 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 421 次浏览 • 2021-09-23 23:12

)

使用 Markdown 和 Pandoc,您可以编写一次并发布两次。

Pandoc 是一个命令行工具,用于将文件从一种标记语言转换为另一种标记语言。在我对 Pandoc 的介绍中,我演示了如何将用 Markdown 编写的文本转换为网页、幻灯片和 PDF。

在这个后续文章 中,我将深入研究 Pandoc 并展示如何从同一个 Markdown 源文件生成网页和 ePub 格式的电子书。我将以我即将出版的电子书《面向对象思维的GRASP原则》为例进行说明。这本电子书是通过以下过程创建的。

首先讲解本书使用的文件结构,然后介绍如何使用Pandoc生成网页并部署到GitHub上;最后演示如何生成对应的ePub格式的电子书。

您可以在我的 GitHub 存储库 Programming Fight Club 中找到相应的代码。

设置书籍结构

我使用 Markdown 语法来完成所有写作。也可以使用 HTML 标签,但是 Pandoc 将 Markdown 转换为 ePub 文档时,引入的 HTML 标签越多,出现问题的风险就越大。我的书每章以文件的形式组织,每章的标题都用Markdown的H1标记(#)来声明。您也可以在每个文件中放置多个章节,但将它们放在一个单独的文件中可以更轻松地查找内容并在以后更新。

元信息遵循类似的模式,每种输出格式都有自己的元信息文件。元信息文件定义了有关文档的信息,例如要添加到 HTML 或 ePub 许可证的文本。我将所有 Markdown 文档存储在名为 part 的文件夹中(这对于用于生成网页和 ePub 的 Makefile 非常重要)。我们先来看看本书的目录、前言和关于本书(分为三个文件:toc.md、preface.md和about.md)。为清楚起见,我们将省略其余章节。.

这部分书的开头是类似的:

# About this book {-}

## Who should read this book {-}

Before creating a complex software system one needs to create a solid foundation.

General Responsibility Assignment Software Principles (GRASP) are guidelines to assign

responsibilities to software classes in object-oriented programming.

每章完成后,下一步是添加元信息以格式化网页和ePub。

生成 HTML 元信息文件

我创建的网页的元信息文件(web-metadata.yaml)是一个简单的YAML文件,标签中收录作者、标题和版权信息,以及HTML文件的开头和结尾。

我建议(至少)在 web-metadata.yaml 文件中收录以下字段:

---

title: GRASP principles for the Object-oriented mind

author: Kiko Fernandez-Reyes

rights: 2017 Kiko Fernandez-Reyes, CC-BY-NC-SA 4.0 International

header-includes:

- |

```{=html}

```

include-before:

- |

```{=html}

<p>If you like this book, please consider

spreading the word or

buying me a coffee

```

include-after:

- |

```{=html}

Designed with ❤️ from Uppsala, Sweden

```

---</p>

以下变量需要注意:

这些只是一些可用的变量。查看HTML中的模板变量(我的文章Pandoc介绍中描述了如何查看LaTeX模板变量,查看HTML模板变量的过程是一样的)了解剩余的变量。

将页面分成几章

网页可以作为一个整体生成,这会产生一个收录所有内容的长页面;也可以分成多个章节,我觉得会更容易阅读。我将解释如何将页面分成章节,以便读者不会被长页面吓倒。

为了使网页在 GitHub Pages 上易于部署,您需要创建一个名为 docs 的根文件夹(这是 GitHub Pages 默认用于渲染网页的根文件夹)。然后我们需要在docs下为每一章创建一个文件夹,把HTML内容放在自己的文件夹中,把文件内容放在一个名为index.html的文件中。

例如,about.md 文件将被转换为名为 index.html 的文件,该文件位于名为 about (about/index.html) 的文件夹中。这样,当用户键入 /about/ 时,文件夹中的 index.html 文件将显示在他们的浏览器中。

以下 Makefile 将执行上述所有操作:

# Your book files

DEPENDENCIES= toc preface about

# Placement of your HTML files

DOCS=docs

all: web

web: setup $(DEPENDENCIES)

@cp $(DOCS)/toc/index.html $(DOCS)

# Creation and copy of stylesheet and images into

# the assets folder. This is important to deploy the

# website to Github Pages.

setup:

@mkdir -p $(DOCS)

@cp -r assets $(DOCS)

# Creation of folder and index.html file on a

# per-chapter basis

$(DEPENDENCIES):

@mkdir -p $(DOCS)/$@

@pandoc -s --toc web-metadata.yaml parts/$@.md \

-c /assets/pandoc.css -o $(DOCS)/$@/index.html

clean:

@rm -rf $(DOCS)

.PHONY: all clean web setup

选项-c /assets/pandoc.css 声明要使用的CSS 样式表,它将从/assets/pandoc.cs 获得。换句话说,在标签中,Pandoc 会添加这一行:

使用以下命令生成网页:

make

根文件夹现在应收录以下文件结构:

.---parts

| |--- toc.md

| |--- preface.md

| |--- about.md

|

|---docs

|--- assets/

|--- index.html

|--- toc

| |--- index.html

|

|--- preface

| |--- index.html

|

|--- about

|--- index.html

部署网页

使用以下步骤将网页部署到 GitHub:

创建一个新的 GitHub 存储库并将内容推送到新创建的存储库。在存储库设置中找到 GitHub Pages 部分,然后选择 Source 选项,让 GitHub 使用 master 分支的内容。

您可以在 GitHub Pages 上获得有关 网站 的更多详细信息。

我的书的网页就是通过上面的过程生成的,结果可以在网页上查看。

生成电子书并创建 ePub 格式的元信息文件

ePub 格式的元信息文件 epub-meta.yaml 类似于 HTML 元信息文件。主要区别在于 ePub 提供了其他模板变量,例如publisher 和cover-image。ePub 格式书籍的样式表可能与网页上使用的样式表不同。这里我使用了一个名为 epub.css 的样式表。

---

title: 'GRASP principles for the Object-oriented Mind'

publisher: 'Programming Language Fight Club'

author: Kiko Fernandez-Reyes

rights: 2017 Kiko Fernandez-Reyes, CC-BY-NC-SA 4.0 International

cover-image: assets/cover.png

stylesheet: assets/epub.css

...

将以下内容添加到之前的 Makefile 中:

epub:

@pandoc -s --toc epub-meta.yaml \

$(addprefix parts/, $(DEPENDENCIES:=.md)) -o $(DOCS)/assets/book.epub

用于生成 ePub 格式书籍的命令从 HTML 版本中获取所有依赖项(每个章节的名称),为其添加 Markdown 扩展,并在它们前面加上每个章节的文件夹路径,以便 Pandoc 知道如何处理它。例如,如果 $(DEPENDENCIES 变量只收录“前言”和“关于本书”章节,那么 Makefile 将像这样调用:

@pandoc -s --toc epub-meta.yaml \

parts/preface.md parts/about.md -o $(DOCS)/assets/book.epub

Pandoc 会提取这两章的内容,然后将它们组合起来,最后生成一个 ePub 格式的电子书并将其放置在 Assets 文件夹中。

这是使用此过程创建 ePub 格式电子书的示例。

流程总结

从 Markdown 文件创建网页和 ePub 格式电子书的过程并不难,但有很多细节需要注意。遵循下面的大纲可能会使您更容易使用 Pandoc。

ePub 电子书:

通过:

作者:Kiko Fernandez-Reyes 主题:lujun9972 译者:jlztan 校对:wxy

本文由LCTT原创编译,Linux中国荣幸推出

查看全部

抓取网页生成电子书(如何从同一个Markdown源文件生成网页和ePub格式的电子书

)

使用 Markdown 和 Pandoc,您可以编写一次并发布两次。

Pandoc 是一个命令行工具,用于将文件从一种标记语言转换为另一种标记语言。在我对 Pandoc 的介绍中,我演示了如何将用 Markdown 编写的文本转换为网页、幻灯片和 PDF。

在这个后续文章 中,我将深入研究 Pandoc 并展示如何从同一个 Markdown 源文件生成网页和 ePub 格式的电子书。我将以我即将出版的电子书《面向对象思维的GRASP原则》为例进行说明。这本电子书是通过以下过程创建的。

首先讲解本书使用的文件结构,然后介绍如何使用Pandoc生成网页并部署到GitHub上;最后演示如何生成对应的ePub格式的电子书。

您可以在我的 GitHub 存储库 Programming Fight Club 中找到相应的代码。

设置书籍结构

我使用 Markdown 语法来完成所有写作。也可以使用 HTML 标签,但是 Pandoc 将 Markdown 转换为 ePub 文档时,引入的 HTML 标签越多,出现问题的风险就越大。我的书每章以文件的形式组织,每章的标题都用Markdown的H1标记(#)来声明。您也可以在每个文件中放置多个章节,但将它们放在一个单独的文件中可以更轻松地查找内容并在以后更新。

元信息遵循类似的模式,每种输出格式都有自己的元信息文件。元信息文件定义了有关文档的信息,例如要添加到 HTML 或 ePub 许可证的文本。我将所有 Markdown 文档存储在名为 part 的文件夹中(这对于用于生成网页和 ePub 的 Makefile 非常重要)。我们先来看看本书的目录、前言和关于本书(分为三个文件:toc.md、preface.md和about.md)。为清楚起见,我们将省略其余章节。.

这部分书的开头是类似的:

# About this book {-}

## Who should read this book {-}

Before creating a complex software system one needs to create a solid foundation.

General Responsibility Assignment Software Principles (GRASP) are guidelines to assign

responsibilities to software classes in object-oriented programming.

每章完成后,下一步是添加元信息以格式化网页和ePub。

生成 HTML 元信息文件

我创建的网页的元信息文件(web-metadata.yaml)是一个简单的YAML文件,标签中收录作者、标题和版权信息,以及HTML文件的开头和结尾。

我建议(至少)在 web-metadata.yaml 文件中收录以下字段:

---

title: GRASP principles for the Object-oriented mind

author: Kiko Fernandez-Reyes

rights: 2017 Kiko Fernandez-Reyes, CC-BY-NC-SA 4.0 International

header-includes:

- |

```{=html}

```

include-before:

- |

```{=html}

<p>If you like this book, please consider

spreading the word or

buying me a coffee

```

include-after:

- |

```{=html}

Designed with ❤️ from Uppsala, Sweden

```

---</p>

以下变量需要注意:

这些只是一些可用的变量。查看HTML中的模板变量(我的文章Pandoc介绍中描述了如何查看LaTeX模板变量,查看HTML模板变量的过程是一样的)了解剩余的变量。

将页面分成几章

网页可以作为一个整体生成,这会产生一个收录所有内容的长页面;也可以分成多个章节,我觉得会更容易阅读。我将解释如何将页面分成章节,以便读者不会被长页面吓倒。

为了使网页在 GitHub Pages 上易于部署,您需要创建一个名为 docs 的根文件夹(这是 GitHub Pages 默认用于渲染网页的根文件夹)。然后我们需要在docs下为每一章创建一个文件夹,把HTML内容放在自己的文件夹中,把文件内容放在一个名为index.html的文件中。

例如,about.md 文件将被转换为名为 index.html 的文件,该文件位于名为 about (about/index.html) 的文件夹中。这样,当用户键入 /about/ 时,文件夹中的 index.html 文件将显示在他们的浏览器中。

以下 Makefile 将执行上述所有操作:

# Your book files

DEPENDENCIES= toc preface about

# Placement of your HTML files

DOCS=docs

all: web

web: setup $(DEPENDENCIES)

@cp $(DOCS)/toc/index.html $(DOCS)

# Creation and copy of stylesheet and images into

# the assets folder. This is important to deploy the

# website to Github Pages.

setup:

@mkdir -p $(DOCS)

@cp -r assets $(DOCS)

# Creation of folder and index.html file on a

# per-chapter basis

$(DEPENDENCIES):

@mkdir -p $(DOCS)/$@

@pandoc -s --toc web-metadata.yaml parts/$@.md \

-c /assets/pandoc.css -o $(DOCS)/$@/index.html

clean:

@rm -rf $(DOCS)

.PHONY: all clean web setup

选项-c /assets/pandoc.css 声明要使用的CSS 样式表,它将从/assets/pandoc.cs 获得。换句话说,在标签中,Pandoc 会添加这一行:

使用以下命令生成网页:

make

根文件夹现在应收录以下文件结构:

.---parts

| |--- toc.md

| |--- preface.md

| |--- about.md

|

|---docs

|--- assets/

|--- index.html

|--- toc

| |--- index.html

|

|--- preface

| |--- index.html

|

|--- about

|--- index.html

部署网页

使用以下步骤将网页部署到 GitHub:

创建一个新的 GitHub 存储库并将内容推送到新创建的存储库。在存储库设置中找到 GitHub Pages 部分,然后选择 Source 选项,让 GitHub 使用 master 分支的内容。

您可以在 GitHub Pages 上获得有关 网站 的更多详细信息。

我的书的网页就是通过上面的过程生成的,结果可以在网页上查看。

生成电子书并创建 ePub 格式的元信息文件

ePub 格式的元信息文件 epub-meta.yaml 类似于 HTML 元信息文件。主要区别在于 ePub 提供了其他模板变量,例如publisher 和cover-image。ePub 格式书籍的样式表可能与网页上使用的样式表不同。这里我使用了一个名为 epub.css 的样式表。

---

title: 'GRASP principles for the Object-oriented Mind'

publisher: 'Programming Language Fight Club'

author: Kiko Fernandez-Reyes

rights: 2017 Kiko Fernandez-Reyes, CC-BY-NC-SA 4.0 International

cover-image: assets/cover.png

stylesheet: assets/epub.css

...

将以下内容添加到之前的 Makefile 中:

epub:

@pandoc -s --toc epub-meta.yaml \

$(addprefix parts/, $(DEPENDENCIES:=.md)) -o $(DOCS)/assets/book.epub

用于生成 ePub 格式书籍的命令从 HTML 版本中获取所有依赖项(每个章节的名称),为其添加 Markdown 扩展,并在它们前面加上每个章节的文件夹路径,以便 Pandoc 知道如何处理它。例如,如果 $(DEPENDENCIES 变量只收录“前言”和“关于本书”章节,那么 Makefile 将像这样调用:

@pandoc -s --toc epub-meta.yaml \

parts/preface.md parts/about.md -o $(DOCS)/assets/book.epub

Pandoc 会提取这两章的内容,然后将它们组合起来,最后生成一个 ePub 格式的电子书并将其放置在 Assets 文件夹中。

这是使用此过程创建 ePub 格式电子书的示例。

流程总结

从 Markdown 文件创建网页和 ePub 格式电子书的过程并不难,但有很多细节需要注意。遵循下面的大纲可能会使您更容易使用 Pandoc。

ePub 电子书:

通过:

作者:Kiko Fernandez-Reyes 主题:lujun9972 译者:jlztan 校对:wxy

本文由LCTT原创编译,Linux中国荣幸推出

抓取网页生成电子书(手动排版书籍制作成电子书籍的实用工具(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 313 次浏览 • 2021-09-23 08:15

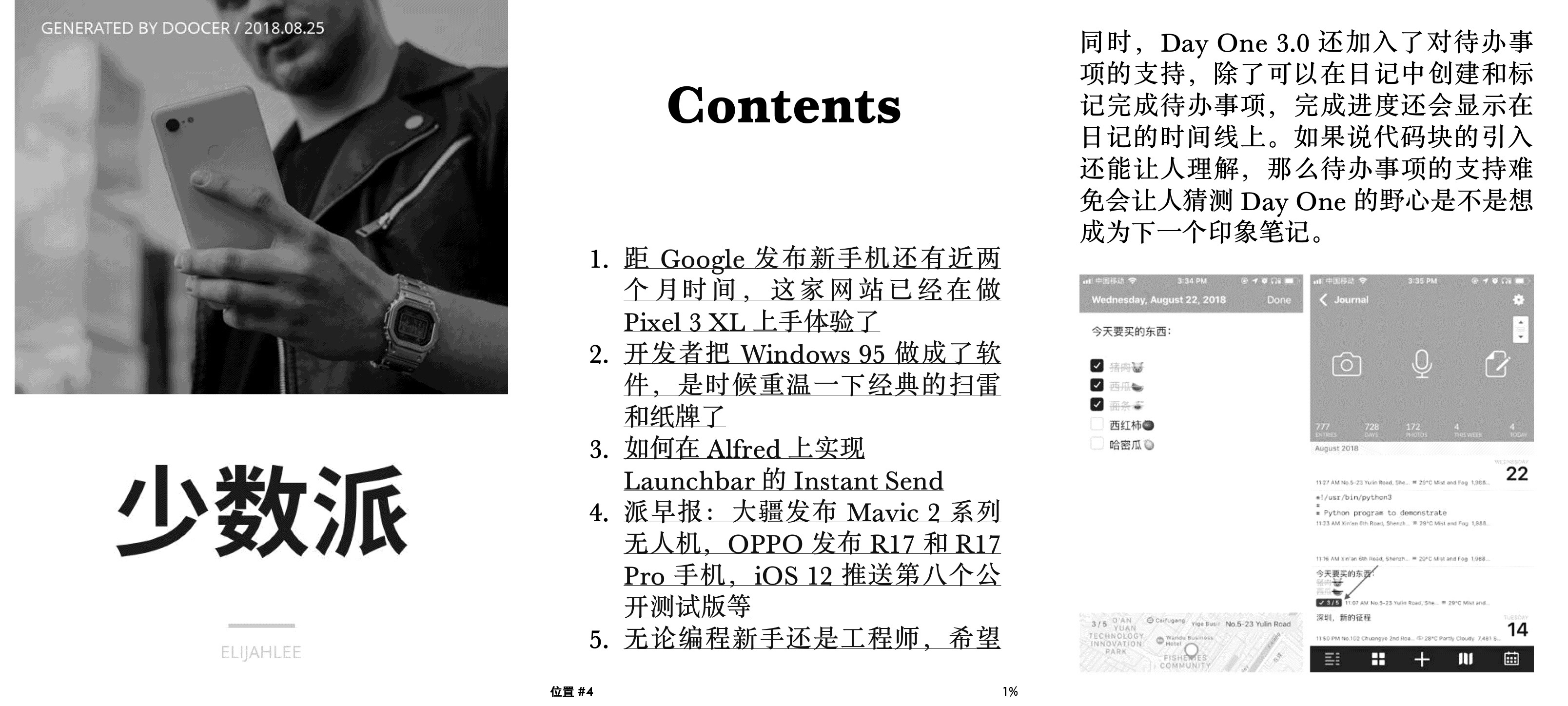

我一直在研究页面如何看待或文章 @ @ 文章kindle严肃阅读,但很长一段时间但不幸的是没有真正的进步。虽然制作手动排版书籍电子书的方法很简单,但对于短的长度,经常更新的网页文章,这种方法的效率很低。如果您有一个工具文章 Batch Capture,生成电子书,直接推送到Kindle,那么它可能不会更好。垃圾箱是这样的效用。

Doocer @lepture由在线服务开发,允许用户提交URL,RSS Feeds地址以及稍后在文章的帐户中读取的口袋,然后逐个或批量生入EPUB,Mobi E-Books 。您可以在所有文章中直接阅读DoOcer,或将它们推到Kindle,Apple书籍中阅读。

真的很好阅读体验

Doocer生成电子书,排版精细值得称道,正如许多内容中的一些内容,一些内容不应该那么多。仅书籍封面插图,文章目录,网站 source,文章作者和其他可用的其他信息。 Doocer生成的Mobi电子书支持KF8标准,因此支持本机Kindle自定义字体替换功能。

谢谢网站文章通常具有标准的一般布局规范,Doocer生成电子书文章在标题的大小中,图例列表与原创页面文章 文章高度一致。原创文章的超链接是所有保留的,审查信息,广告和其他内容都被拒绝。整本书阅读体验非常友好。 (当然,如果原创页面布局文章无能为用,所生成的电子书也可能完全不同。)

网页文章进入电子书

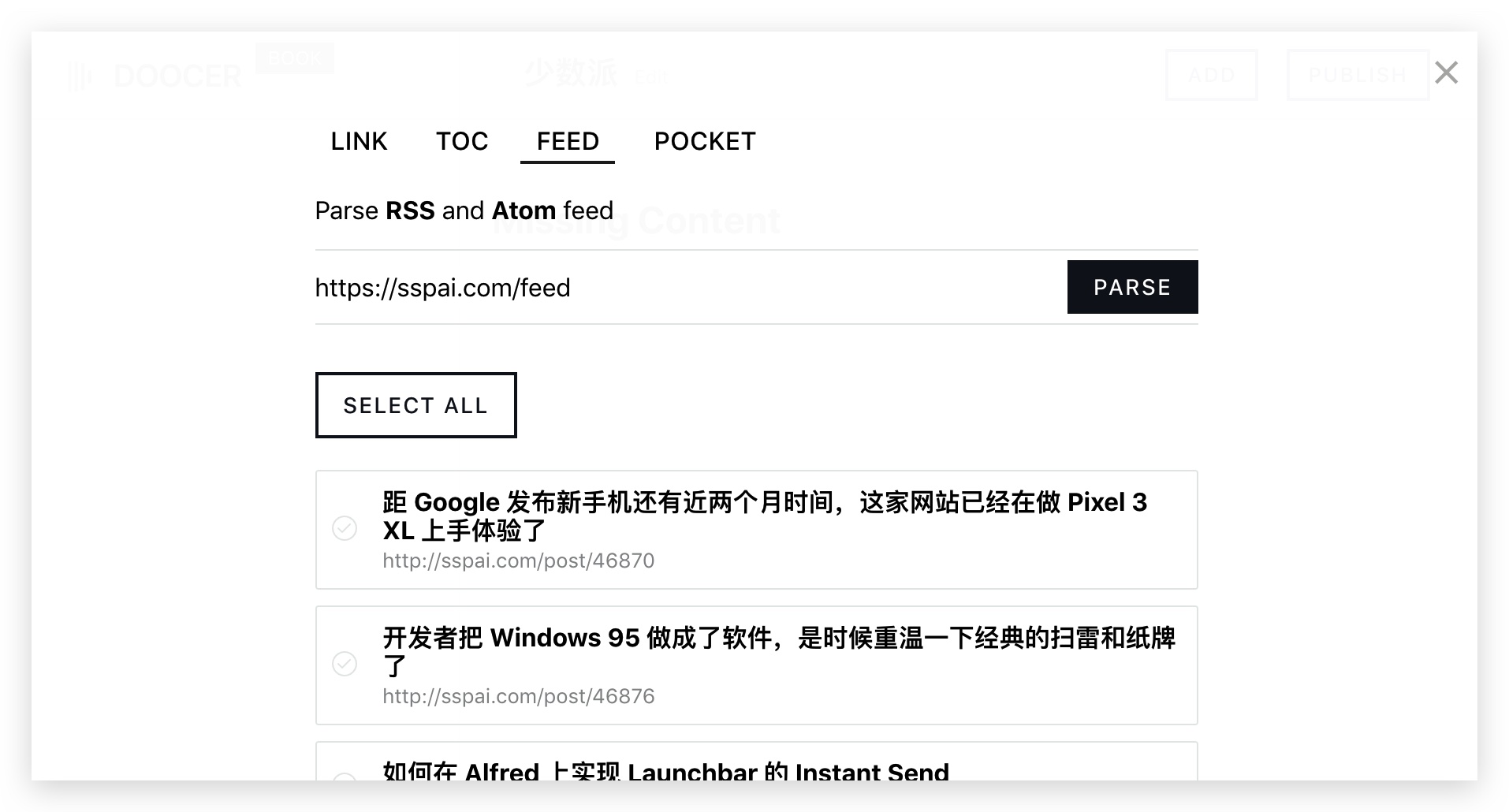

完成登记登录Doocer后,我们可以开始进入网页文章 E-Book。首先,我们点击“新书”按钮,以创建一个新的电子书,电子书,输入名称。接下来,在右上角选择“添加”以添加文章 URL或RSS馈送地址。

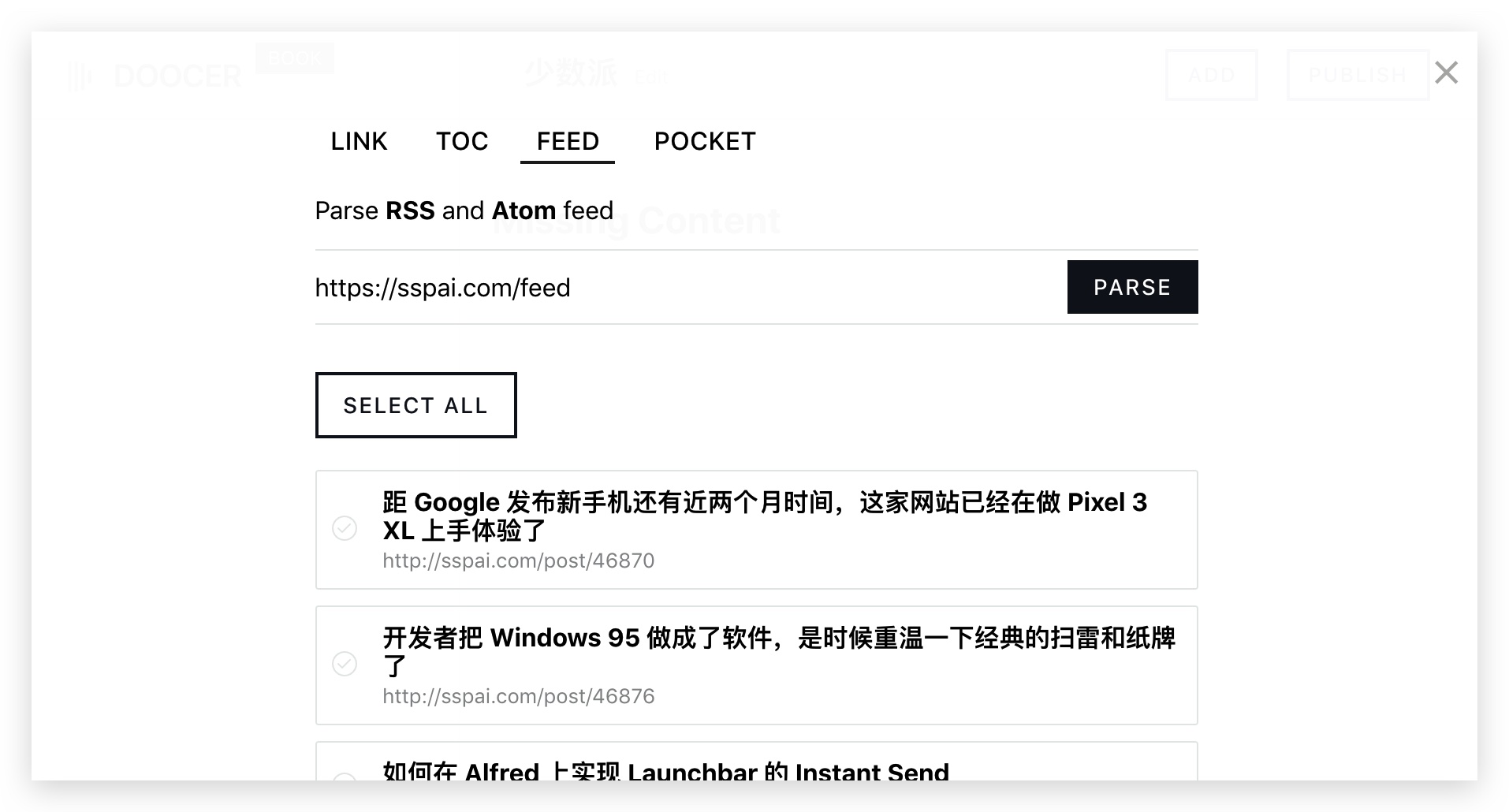

到少数群体页面文章示例,我们选择“feed”并粘贴输入框中的RSS地址,然后单击“解析”,然后将显示少数文章列表以供我们添加。我们可以选择选项,您可以单击“选择全部”以选择所有文章。最后到页面的底部,选择“保存”,然后这些文章将被添加到内部的书籍中。

事实上,DoOcer Web和RSS工具非常相似,即在网站,展示功能中实现批量获取文章 文章。

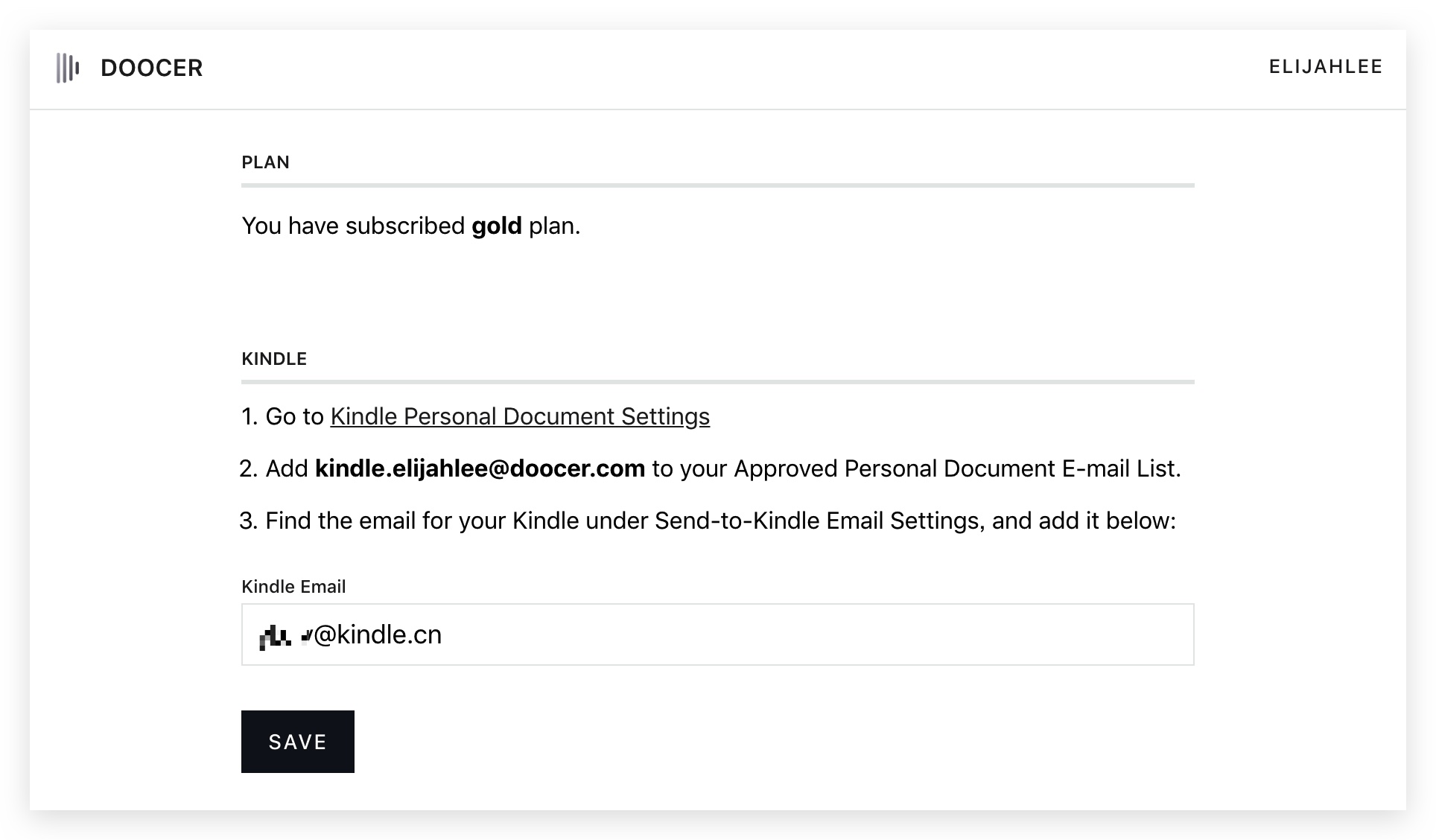

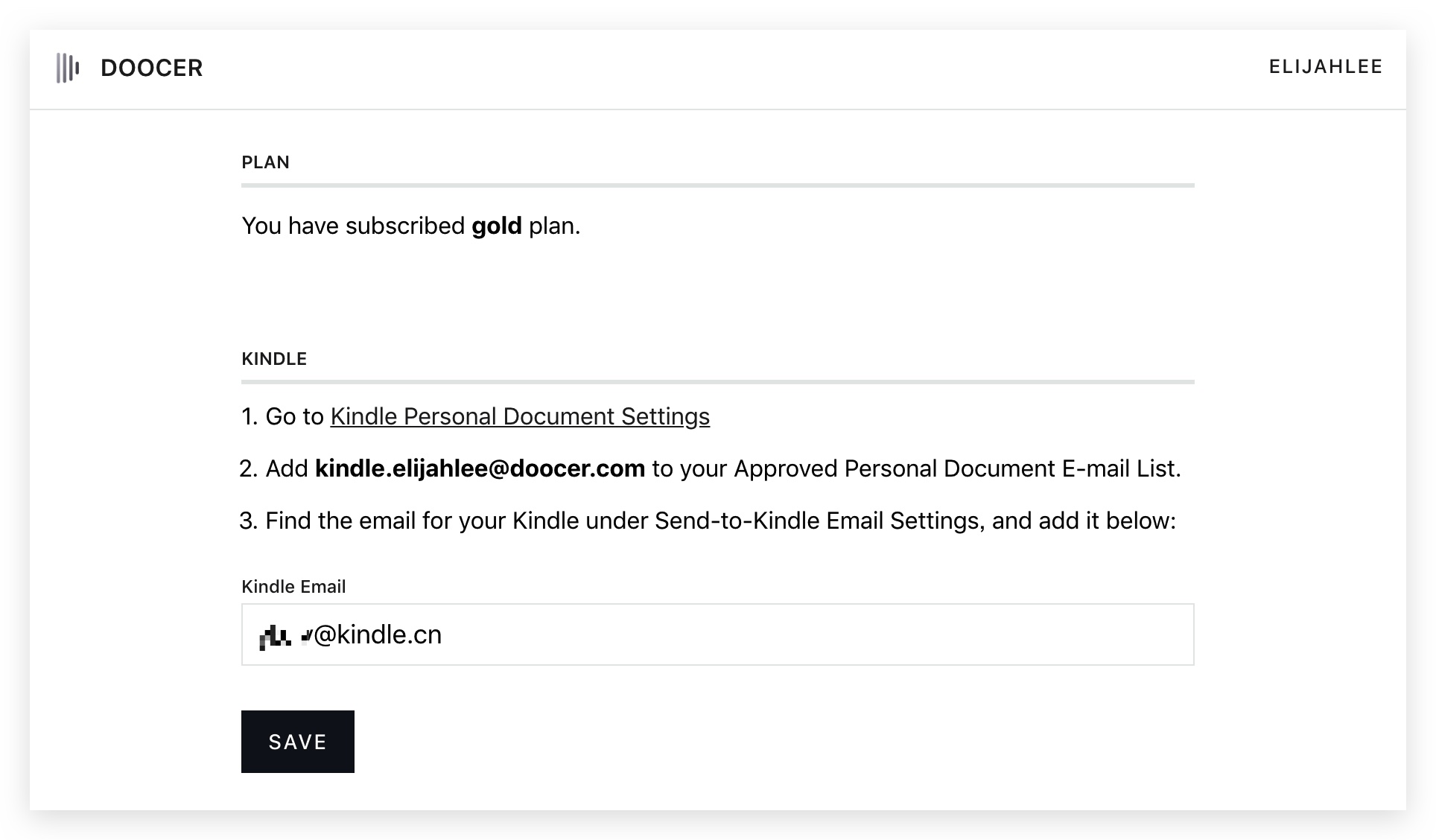

将这些文章推入电子书和点燃,我们必须执行一些简单的操作。

首先,根据Doocer个人设置的提示,我们打开文档设置个人亚马逊Kindle,电子书将Doocer发送地址添加到个人地址中以接收文档。完成后,我们将在地址输入框中填写Kindle个人文档,单击“保存”。

最后,我们在“少数民族”这本书中打开了Doocer,找到了“发布”页面,然后选择“发送给Kindle”。大约10到30分钟,垃圾桶将完成书籍生产,并预订推动的Kindle去。

有一些问题需要注意

Doocer现在处于测试阶段,仍然存在一些错误,特别是常用于汉语@ @ @的问题。幸运的是,有一个对话渠道Doocer官方网站开发人员,他可以直接联系以帮助解决。

为了在所有操作中自动化流程,我认为它是最需要的垃圾送力。 Doocer可以像RSS这样的Web 文章工具中更新,但将添加到爬网文章并生成电子书以及推送,或者需要手动。如果您可以自动化整个过程,RSS - Mobi - Kindle Go,并且我相信它将是更高水平的有用性。 查看全部

抓取网页生成电子书(手动排版书籍制作成电子书籍的实用工具(组图))

我一直在研究页面如何看待或文章 @ @ 文章kindle严肃阅读,但很长一段时间但不幸的是没有真正的进步。虽然制作手动排版书籍电子书的方法很简单,但对于短的长度,经常更新的网页文章,这种方法的效率很低。如果您有一个工具文章 Batch Capture,生成电子书,直接推送到Kindle,那么它可能不会更好。垃圾箱是这样的效用。

Doocer @lepture由在线服务开发,允许用户提交URL,RSS Feeds地址以及稍后在文章的帐户中读取的口袋,然后逐个或批量生入EPUB,Mobi E-Books 。您可以在所有文章中直接阅读DoOcer,或将它们推到Kindle,Apple书籍中阅读。

真的很好阅读体验

Doocer生成电子书,排版精细值得称道,正如许多内容中的一些内容,一些内容不应该那么多。仅书籍封面插图,文章目录,网站 source,文章作者和其他可用的其他信息。 Doocer生成的Mobi电子书支持KF8标准,因此支持本机Kindle自定义字体替换功能。

谢谢网站文章通常具有标准的一般布局规范,Doocer生成电子书文章在标题的大小中,图例列表与原创页面文章 文章高度一致。原创文章的超链接是所有保留的,审查信息,广告和其他内容都被拒绝。整本书阅读体验非常友好。 (当然,如果原创页面布局文章无能为用,所生成的电子书也可能完全不同。)

网页文章进入电子书

完成登记登录Doocer后,我们可以开始进入网页文章 E-Book。首先,我们点击“新书”按钮,以创建一个新的电子书,电子书,输入名称。接下来,在右上角选择“添加”以添加文章 URL或RSS馈送地址。

到少数群体页面文章示例,我们选择“feed”并粘贴输入框中的RSS地址,然后单击“解析”,然后将显示少数文章列表以供我们添加。我们可以选择选项,您可以单击“选择全部”以选择所有文章。最后到页面的底部,选择“保存”,然后这些文章将被添加到内部的书籍中。

事实上,DoOcer Web和RSS工具非常相似,即在网站,展示功能中实现批量获取文章 文章。

将这些文章推入电子书和点燃,我们必须执行一些简单的操作。

首先,根据Doocer个人设置的提示,我们打开文档设置个人亚马逊Kindle,电子书将Doocer发送地址添加到个人地址中以接收文档。完成后,我们将在地址输入框中填写Kindle个人文档,单击“保存”。

最后,我们在“少数民族”这本书中打开了Doocer,找到了“发布”页面,然后选择“发送给Kindle”。大约10到30分钟,垃圾桶将完成书籍生产,并预订推动的Kindle去。

有一些问题需要注意

Doocer现在处于测试阶段,仍然存在一些错误,特别是常用于汉语@ @ @的问题。幸运的是,有一个对话渠道Doocer官方网站开发人员,他可以直接联系以帮助解决。

为了在所有操作中自动化流程,我认为它是最需要的垃圾送力。 Doocer可以像RSS这样的Web 文章工具中更新,但将添加到爬网文章并生成电子书以及推送,或者需要手动。如果您可以自动化整个过程,RSS - Mobi - Kindle Go,并且我相信它将是更高水平的有用性。

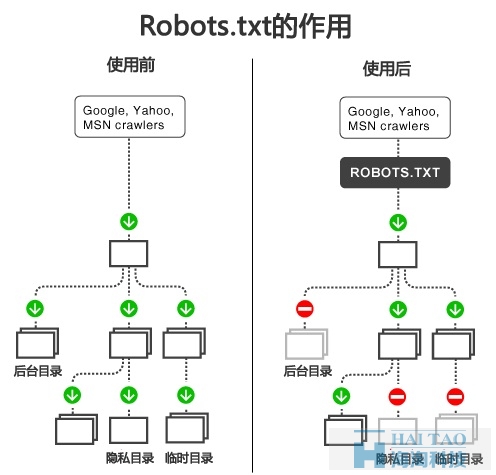

抓取网页生成电子书( 网站通过Robots协议告诉搜索引擎哪些页面不能被查看)

网站优化 • 优采云 发表了文章 • 0 个评论 • 109 次浏览 • 2021-09-22 21:18

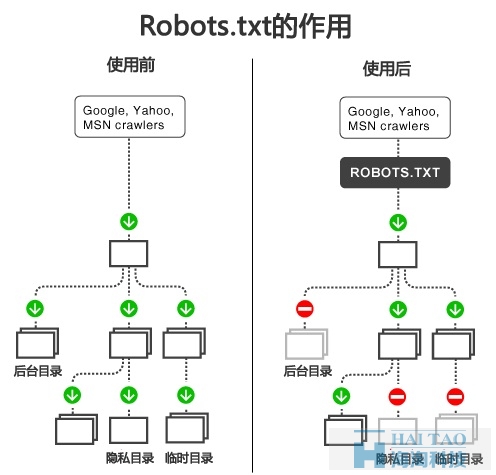

网站通过Robots协议告诉搜索引擎哪些页面不能被查看)

生产和使用

网站 robots.txt文件

机器人协议(也称为爬虫协议,机器人协议等)的全称是“网络爬虫排除标准”(机器人排除协议),网站告诉搜索引擎,其通过机器人协议网页可以抓取,该页面可以赶不上接。

robots.txt文件是使用任何常用的文本编辑器,如Windows系统的文本文件自带的记事本,您可以创建和编辑它的robots.txt是一个协议,而不是一个命令。 robots.txt文件是第一次网站搜索引擎访问您要查看。 robots.txt文件告诉蜘蛛哪些文件可以被视为在服务器上。

当一个搜索蜘蛛访问一个网站时,它将首先检查是否有在该网站的根目录的robots.txt,如果存在的话,以确定搜索机器人的范围将根据文件的内容访问;如果文件不存在,所有的搜索蜘蛛将无法访问网站所有受密码保护的网页。百度官方推荐只有当你的网站不想被包括在@ 收录内容,需要一个robots.txt文件搜索引擎。如果你想在搜索引擎上的所有内容收录 网站@ @,不创建一个robots.txt文件。

如果在网站视为一个酒店房间,robots.txt的是房间的门挂“请勿打扰”或所有者“欢迎干净”的提示牌。此文件告诉来访的搜索引擎室进入并访问其中,因为什么空间来存储贵重物品,或可能涉及居民和游客不开放给搜索引擎的隐私。然而,robots.txt的不是命令,而不是一个防火墙,因为网守不能防止盗窃和其他恶意入侵者。

大家都知道,在robots.txt文件网站优化,是一个沉重的脚步,我们的robots.txt正确书写有利于我们的优化,我们需要知道它是一个协议,可以说该协议爬行动物,机器人协议。它的作用是告诉搜索引擎蜘蛛我们网站这些页面可以抓取,那些谁不能抓取,所以这一步是SEO 网站最优化是非常重要的,但是这一步也是很认真的写,一次写入错了,这是非常严重的自身网站会,如错误的目录,那么这个目录会导致事情不被抓取,所以我们必须了解我们网站架构,我们每个目录知道是什么这意味着,这将有助于我们写的robots.txt协议,直到搞懂自己网站架构@,最好不要写的robots.txt。首先了解说。现在,我会说一些关于生产方法和使用方法:

我们只需要知道两个标签,允许和禁止的首先,许可证,一个是不允许的,相对于它的作用,我们都可以理解。我们绝不能混淆,以及一个符号:*该符号表示:所有的意义

用户代理:*

不允许:

或

用户代理:*

允许:

如果我想屏蔽索索蜘蛛抓取,

用户代理:sosospider

不允许:/

我们可以发现这种蜘蛛盾,使上述比较只是多了一个“/”,其含义是完全不同的,所以当字迹要小心,因为不能写斜线堵住蜘蛛甚至不知道。有在用户代理:蜘蛛命名后面蔑视固定,如果它是用“*”表示所有为蜘蛛

我们希望禁止网站文件在目录不允许搜索引擎蜘蛛爬行到:

用户代理:*

不允许:/目录/.

如果这是为了防止一个目录的爬行,然后将目录名时一定要注意“/”,没有“/”阻止访问网页的目录页和目录,并把“/”表示目录到页面下的停止内容,这两点讲清楚。如果你想屏蔽多个目录需要使用。

如果蜘蛛是为了防止访问某些类型的文件,例如阻止爬行.jpg格式的图像可以被设置为:

用户代理:*

不允许名:.jpg $

?!

如果我网站后缀多页目录号,怎么写呢,我们可以写;

用户代理:*

不允许:? / *

最后,我们写出的robots.txt时间,我们必须大写和小写字母之间进行区分,而且被写入的robots.txt 网站根目录。对生产网站 robots.txt文件,每个人都已经知道这件事? 查看全部

抓取网页生成电子书(

网站通过Robots协议告诉搜索引擎哪些页面不能被查看)

生产和使用

网站 robots.txt文件

机器人协议(也称为爬虫协议,机器人协议等)的全称是“网络爬虫排除标准”(机器人排除协议),网站告诉搜索引擎,其通过机器人协议网页可以抓取,该页面可以赶不上接。

robots.txt文件是使用任何常用的文本编辑器,如Windows系统的文本文件自带的记事本,您可以创建和编辑它的robots.txt是一个协议,而不是一个命令。 robots.txt文件是第一次网站搜索引擎访问您要查看。 robots.txt文件告诉蜘蛛哪些文件可以被视为在服务器上。

当一个搜索蜘蛛访问一个网站时,它将首先检查是否有在该网站的根目录的robots.txt,如果存在的话,以确定搜索机器人的范围将根据文件的内容访问;如果文件不存在,所有的搜索蜘蛛将无法访问网站所有受密码保护的网页。百度官方推荐只有当你的网站不想被包括在@ 收录内容,需要一个robots.txt文件搜索引擎。如果你想在搜索引擎上的所有内容收录 网站@ @,不创建一个robots.txt文件。

如果在网站视为一个酒店房间,robots.txt的是房间的门挂“请勿打扰”或所有者“欢迎干净”的提示牌。此文件告诉来访的搜索引擎室进入并访问其中,因为什么空间来存储贵重物品,或可能涉及居民和游客不开放给搜索引擎的隐私。然而,robots.txt的不是命令,而不是一个防火墙,因为网守不能防止盗窃和其他恶意入侵者。

大家都知道,在robots.txt文件网站优化,是一个沉重的脚步,我们的robots.txt正确书写有利于我们的优化,我们需要知道它是一个协议,可以说该协议爬行动物,机器人协议。它的作用是告诉搜索引擎蜘蛛我们网站这些页面可以抓取,那些谁不能抓取,所以这一步是SEO 网站最优化是非常重要的,但是这一步也是很认真的写,一次写入错了,这是非常严重的自身网站会,如错误的目录,那么这个目录会导致事情不被抓取,所以我们必须了解我们网站架构,我们每个目录知道是什么这意味着,这将有助于我们写的robots.txt协议,直到搞懂自己网站架构@,最好不要写的robots.txt。首先了解说。现在,我会说一些关于生产方法和使用方法:

我们只需要知道两个标签,允许和禁止的首先,许可证,一个是不允许的,相对于它的作用,我们都可以理解。我们绝不能混淆,以及一个符号:*该符号表示:所有的意义

用户代理:*

不允许:

或

用户代理:*

允许:

如果我想屏蔽索索蜘蛛抓取,

用户代理:sosospider

不允许:/

我们可以发现这种蜘蛛盾,使上述比较只是多了一个“/”,其含义是完全不同的,所以当字迹要小心,因为不能写斜线堵住蜘蛛甚至不知道。有在用户代理:蜘蛛命名后面蔑视固定,如果它是用“*”表示所有为蜘蛛

我们希望禁止网站文件在目录不允许搜索引擎蜘蛛爬行到:

用户代理:*

不允许:/目录/.

如果这是为了防止一个目录的爬行,然后将目录名时一定要注意“/”,没有“/”阻止访问网页的目录页和目录,并把“/”表示目录到页面下的停止内容,这两点讲清楚。如果你想屏蔽多个目录需要使用。

如果蜘蛛是为了防止访问某些类型的文件,例如阻止爬行.jpg格式的图像可以被设置为:

用户代理:*

不允许名:.jpg $

?!

如果我网站后缀多页目录号,怎么写呢,我们可以写;

用户代理:*

不允许:? / *

最后,我们写出的robots.txt时间,我们必须大写和小写字母之间进行区分,而且被写入的robots.txt 网站根目录。对生产网站 robots.txt文件,每个人都已经知道这件事?

抓取网页生成电子书(网络书籍抓取器的软件特色及软件)

网站优化 • 优采云 发表了文章 • 0 个评论 • 163 次浏览 • 2021-09-20 00:12

网络图书抓取器主要用于抓取网络小说生成的文本文件。它可以提取和调整指定小说目录页面的章节信息,然后根据章节顺序获取小说内容,然后进行合并。此外,抓取过程可以随时中断,程序可以继续执行最后一个任务,而不必担心突然错误的原因。回想起来,我们的很多朋友都喜欢看武侠小说。小编还记得当时我们喜欢看武侠小说,似乎比高考还严肃。特别是近年来,各种奇幻小说如雨后春笋般涌现。虽然质量好或坏,但也有很多好的小说,或是闲暇时值得一读的。随着人们版权意识的增强,我们的许多小说需要收费。虽然我们不支持每个人都看盗版小说,但对于许多学生聚会来说,看合法小说的成本是很大的。虽然一章只有几分钱,但数量是数千章,所以我们的学生聚会无法承载它们

软件功能:

1、章节调整

在线图书抓取器提取目录后,可以进行移动、删除、倒序等调整操作。调整将直接影响最终的书籍,最终的书籍也将根据调整后的章节顺序输出

2、自动重试

在爬行过程中,由于网络因素,可能会发生爬行失败。此程序可以自动重试成功,也可以临时中断爬网(中断后关闭程序不会影响进度),并在网络正常后重试

3、停止并恢复

抓取过程中可随时停止,退出程序后不影响进度(章节信息将保存在记录中,下次运行程序后可恢复抓取。注意:必须先用停止按钮中断程序,然后退出程序。如果直接退出,则不会恢复抓取)

4、一键抓取

又称“傻瓜模式”,基本实现全自动捕获合并功能,直接输出最终文本文件,可能需要在前面输入最基本的网址、保存位等信息(会有明显的操作提示).调整章节后也可以使用一键爬行,爬行合并操作将自动完成

5、适用网站

已经实例化了十本适用的网站(您可以在选择后快速打开网站找到所需的书籍),您还可以自动应用适当的代码,您还可以测试其他小说网站.如果使用,您可以手动将它们添加到设置文件中以备使用

6、易于制作的电子书

可在设置文件中添加各章节名称的前缀和后缀,为后期制作电子书的目录安排带来极大方便

下载地址 查看全部

抓取网页生成电子书(网络书籍抓取器的软件特色及软件)

网络图书抓取器主要用于抓取网络小说生成的文本文件。它可以提取和调整指定小说目录页面的章节信息,然后根据章节顺序获取小说内容,然后进行合并。此外,抓取过程可以随时中断,程序可以继续执行最后一个任务,而不必担心突然错误的原因。回想起来,我们的很多朋友都喜欢看武侠小说。小编还记得当时我们喜欢看武侠小说,似乎比高考还严肃。特别是近年来,各种奇幻小说如雨后春笋般涌现。虽然质量好或坏,但也有很多好的小说,或是闲暇时值得一读的。随着人们版权意识的增强,我们的许多小说需要收费。虽然我们不支持每个人都看盗版小说,但对于许多学生聚会来说,看合法小说的成本是很大的。虽然一章只有几分钱,但数量是数千章,所以我们的学生聚会无法承载它们

软件功能:

1、章节调整

在线图书抓取器提取目录后,可以进行移动、删除、倒序等调整操作。调整将直接影响最终的书籍,最终的书籍也将根据调整后的章节顺序输出

2、自动重试

在爬行过程中,由于网络因素,可能会发生爬行失败。此程序可以自动重试成功,也可以临时中断爬网(中断后关闭程序不会影响进度),并在网络正常后重试

3、停止并恢复

抓取过程中可随时停止,退出程序后不影响进度(章节信息将保存在记录中,下次运行程序后可恢复抓取。注意:必须先用停止按钮中断程序,然后退出程序。如果直接退出,则不会恢复抓取)

4、一键抓取

又称“傻瓜模式”,基本实现全自动捕获合并功能,直接输出最终文本文件,可能需要在前面输入最基本的网址、保存位等信息(会有明显的操作提示).调整章节后也可以使用一键爬行,爬行合并操作将自动完成

5、适用网站

已经实例化了十本适用的网站(您可以在选择后快速打开网站找到所需的书籍),您还可以自动应用适当的代码,您还可以测试其他小说网站.如果使用,您可以手动将它们添加到设置文件中以备使用

6、易于制作的电子书

可在设置文件中添加各章节名称的前缀和后缀,为后期制作电子书的目录安排带来极大方便

下载地址

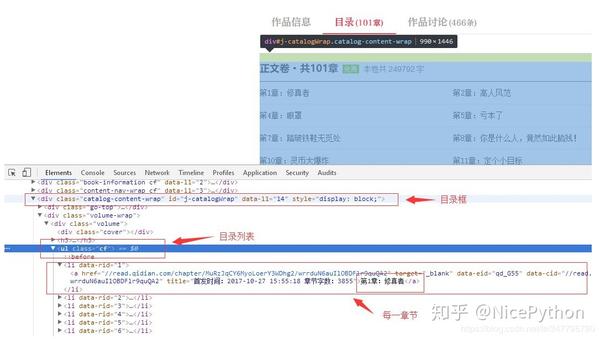

抓取网页生成电子书(如何用Python爬取网页制作电子书思路怎么抓取数据?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 90 次浏览 • 2021-09-20 00:07

作者简介:孙震,软件工程师,长期从事企业信息系统的研发工作。他主要擅长后台业务功能的设计和开发

本文来自作者在gitchat上分享的主题“如何用Python抓取网页以制作电子书”。用scrapy抓取电子书

爬行动物思维

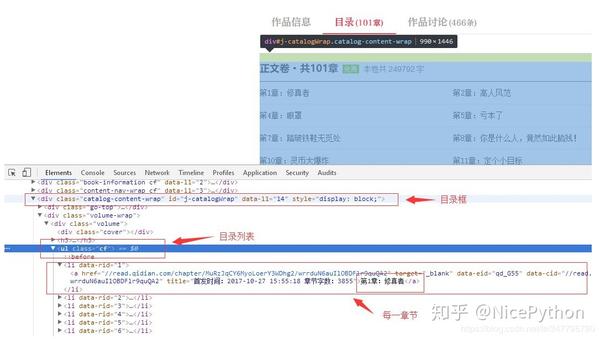

首先,我们需要看看从哪里获得数据。打开秀珍小锚页面,如下图:

有一个目录选项卡。单击此选项卡以查看目录。使用浏览器的元素查看工具,我们可以找到每个章节的目录和相关信息。根据这些信息,我们可以爬到特定页面:

获取章节地址

现在我们打开xzxzb.py文件,它是我们刚刚创建的爬虫程序:

# -*- coding: utf-8 -*-

import scrapy

class XzxzbSpider(scrapy.Spider):

name = 'xzxzb'

allowed_domains = ['qidian.com']

start_urls = ['http://qidian.com/']

def parse(self, response):

pass

start_uuURL是目录地址。爬虫程序将自动爬网此地址,并在下面的解析中处理结果。现在,让我们编写代码来处理目录数据。首先,爬上小说的主页以获取目录列表:

def parse(self, response):

pages = response.xpath('//div[@id="j-catalogWrap"]//ul[@class="cf"]/li')

for page in pages:

url = page.xpath('./child::a/attribute::href').extract()

print url

pass

在网页中获取DOM数据有两种方法,一种是使用CSS选择器,另一种是使用XML XPath查询

这里我们使用XPath。请自行学习相关知识。请看上面的代码。首先,我们通过ID得到目录框,得到类CF,得到目录列表:

pages = response.xpath('//div[@id="j-catalogWrap"]//ul[@class="cf"]/li')

接下来,遍历子节点,在Li标记中查询子节点的href属性,最后将其打印出来:

for page in pages:

url = page.xpath('./child::a/attribute::href').extract()

print url

这样,可以说爬行章节路径的小爬虫已经被编写好了。使用以下命令运行xzzb crawler以查看结果:

scrapy crawl xzxzb

此时,我们的程序中可能会出现以下错误:

…

ImportError: No module named win32api

…

运行以下语句:

pip install pypiwin32

屏幕输出如下所示:

> ...

> [u'//read.qidian.com/chapter/MuRzJqCY6MyoLoerY3WDhg2/wrrduN6auIlOBDFlr9quQA2']

[u'//read.qidian.com/chapter/MuRzJqCY6MyoLoerY3WDhg2/Jh-J5usgyW62uJcMpdsVgA2']

[u'//read.qidian.com/chapter/MuRzJqCY6MyoLoerY3WDhg2/5YXHdBvg1ImaGfXRMrUjdw2']

[u'//read.qidian.com/chapter/MuRzJqCY6MyoLoerY3WDhg2/fw5EBeKat-76ItTi_ILQ7A2']

[u'//read.qidian.com/chapter/MuRzJqCY6MyoLoerY3WDhg2/KsFh5VutI6PwrjbX3WA1AA2']

[u'//read.qidian.com/chapter/MuRzJqCY6MyoLoerY3WDhg2/-mpKJ01gPp1p4rPq4Fd4KQ2']

[u'//read.qidian.com/chapter/MuRzJqCY6MyoLoerY3WDhg2/MlZSeYOQxSPM5j8_3RRvhw2']

[u'//read.qidian.com/chapter/MuRzJqCY6MyoLoerY3WDhg2/5TXZqGvLi-3M5j8_3RRvhw2']

[u'//read.qidian.com/chapter/MuRzJqCY6MyoLoerY3WDhg2/sysD-JPiugv4p8iEw--PPw2']

[u'//read.qidian.com/chapter/MuRzJqCY6MyoLoerY3WDhg2/xGckZ01j64-aGfXRMrUjdw2']

[u'//read.qidian.com/chapter/MuRzJqCY6MyoLoerY3WDhg2/72lHOJcgmedOBDFlr9quQA2']

[u'//read.qidian.com/chapter/MuRzJqCY6MyoLoerY3WDhg2/cZkHZEYnPl22uJcMpdsVgA2']

[u'//read.qidian.com/chapter/MuRzJqCY6MyoLoerY3WDhg2/vkNh45O3JsRMs5iq0oQwLQ2']

[u'//read.qidian.com/chapter/MuRzJqCY6MyoLoerY3WDhg2/ge4m8RjJyPH6ItTi_ILQ7A2']

[u'//read.qidian.com/chapter/MuRzJqCY6MyoLoerY3WDhg2/Y33PuxrKT4dp4rPq4Fd4KQ2']

[u'//read.qidian.com/chapter/MuRzJqCY6MyoLoerY3WDhg2/MDQznkrkiyXwrjbX3WA1AA2']

[u'//read.qidian.com/chapter/MuRzJqCY6MyoLoerY3WDhg2/A2r-YTzWCYj6ItTi_ILQ7A2']

[u'//read.qidian.com/chapter/MuRzJqCY6MyoLoerY3WDhg2/Ng9CuONRKei2uJcMpdsVgA2']

[u'//read.qidian.com/chapter/MuRzJqCY6MyoLoerY3WDhg2/Q_AxWAge14pMs5iq0oQwLQ2']

[u'//read.qidian.com/chapter/MuRzJqCY6MyoLoerY3WDhg2/ZJshvAu8TVVp4rPq4Fd4KQ2']

[u'//read.qidian.com/chapter/MuRzJqCY6MyoLoerY3WDhg2/hYD2P4c5UB2aGfXRMrUjdw2']

[u'//read.qidian.com/chapter/MuRzJqCY6MyoLoerY3WDhg2/muxiWf_jpqTgn4SMoDUcDQ2']

[u'//read.qidian.com/chapter/MuRzJqCY6MyoLoerY3WDhg2/OQQ5jbADJjVp4rPq4Fd4KQ2']

> ...

对章节路径进行爬网的小爬虫已经编写完成,但我们的目的不仅仅是为了实现这一点,我们接下来将使用这些地址来抓取内容:

章页分析

接下来,让我们分析章节页面。从章节页面,我们想要得到标题和内容

如果章节信息爬行使用parser方法,我们可以编写一个方法来爬行每个章节内容,例如parser_uuChapter,首先查看章节页面的详细信息:

您可以看到,本章的全部内容都在div标记中,类名为main text wrap,标题是类名为J_u,是chaptername的H3标记。具体内容是类名为readcontent的readcontent J_uDiv标记

请尝试将此打印出来:

# -*- coding: utf-8 -*-

import scrapy

class XzxzbSpider(scrapy.Spider):

name = 'xzxzb'

allowed_domains = ['qidian.com']

start_urls = ['https://book.qidian.com/info/1010780117/']

def parse(self, response):

pages = response.xpath('//div[@id="j-catalogWrap"]//ul[@class="cf"]/li')

for page in pages:

url = page.xpath('./child::a/attribute::href').extract_first()

# yield scrapy.Request('https:' + url, callback=self.parse_chapter)

yield response.follow(url, callback=self.parse_chapter)

pass

def parse_chapter(self, response):

title = response.xpath('//div[@class="main-text-wrap"]//h3[@class="j_chapterName"]/text()').extract_first().strip()

content = response.xpath('//div[@class="main-text-wrap"]//div[@class="read-content j_readContent"]').extract_first().strip()

print title

# print content

pass

在上一步中,我们获得了一个章节地址,这是输出内容的相对路径,因此我们使用yield response.follow(URL,callback=self.Parse_chapter)。第二个参数是处理章节页面的回调函数。爬网到章节页面后,我们解析页面并将标题保存到文件中

next_page = response.urljoin(url)

yield scrapy.Request(next_page, callback=self.parse_chapter)

与response.follow不同,绝对路径需要通过相对路径构建。Response.follow可以直接使用相对路径,因此不需要调用urljoin方法

请注意,response.follow直接返回一个请求实例,该实例可以通过yield直接返回

获得数据后,将其存储。因为我们想要一个HTML页面,所以我们可以根据标题来存储它。代码如下:

def parse_chapter(self, response):

title = response.xpath('//div[@class="main-text-wrap"]//h3[@class="j_chapterName"]/text()').extract_first().strip()

content = response.xpath('//div[@class="main-text-wrap"]//div[@class="read-content j_readContent"]').extract_first().strip()

# print title

# print content

filename = './down/%s.html' % (title)

with open(filename, 'wb') as f:

f.write(content.encode('utf-8'))

pass

到目前为止,我们已成功捕获数据,但无法直接使用。需要对其进行分类和优化

数据排序

首先,我们爬下来的章节和页面的排序不是很好。如果我们手工安排,需要花费太多的时间和精力;另外,章节内容收录很多附加内容,阅读体验不好。我们需要优化内容的排版和可读性

让我们先把章节排好。因为目录中的章节列表是按顺序排列的,所以我们只需要在下载页面的名称中添加一个序列号

但是保存网页的代码是一个回调函数。只有在处理目录时才能确定顺序。回调函数如何知道顺序?因此,我们需要告诉回调函数处理部分的序列号。我们需要将参数传递给回调函数。修改后的代码如下:

def parse(self, response):

pages = response.xpath('//div[@id="j-catalogWrap"]//ul[@class="cf"]/li')

for page in pages:

url = page.xpath('./child::a/attribute::href').extract_first()

idx = page.xpath('./attribute::data-rid').extract_first()

# yield scrapy.Request('https:' + url, callback=self.parse_chapter)

req = response.follow(url, callback=self.parse_chapter)

req.meta['idx'] = idx

yield req

pass

def parse_chapter(self, response):

idx = response.meta['idx']

title = response.xpath('//div[@class="main-text-wrap"]//h3[@class="j_chapterName"]/text()').extract_first().strip()

content = response.xpath('//div[@class="main-text-wrap"]//div[@class="read-content j_readContent"]').extract_first().strip()

# print title

# print content

filename = './down/%s_%s.html' % (idx, title)

cnt = '%s %s' % (title, content)

with open(filename, 'wb') as f:

f.write(cnt.encode('utf-8'))

pass

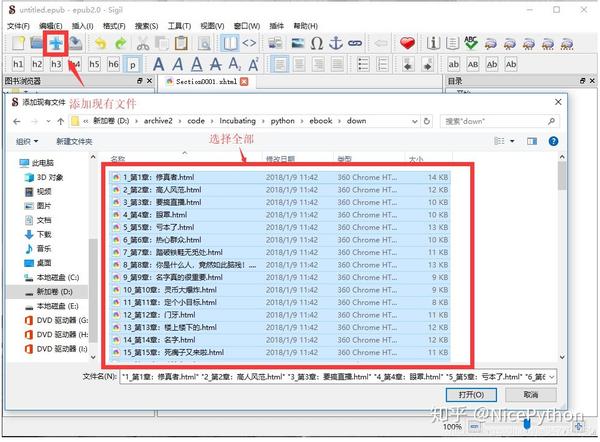

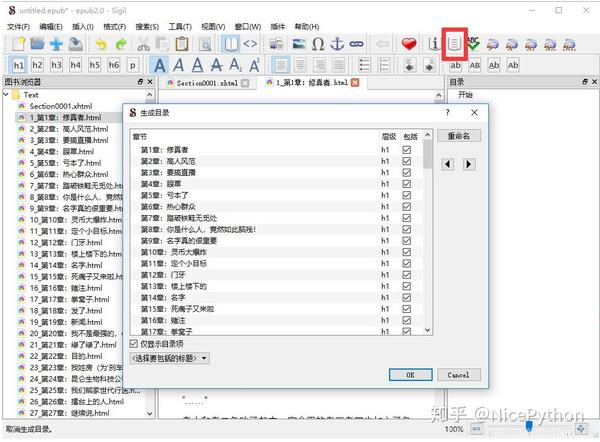

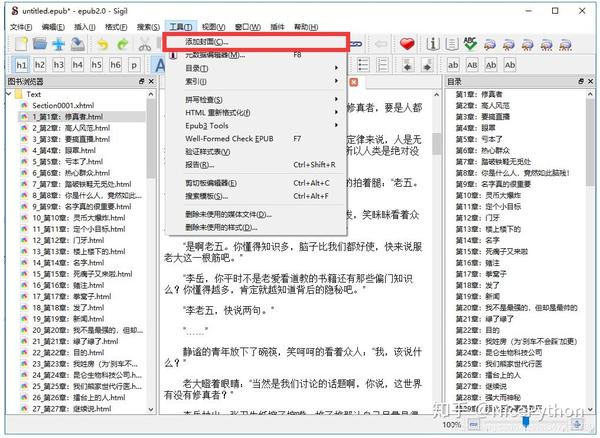

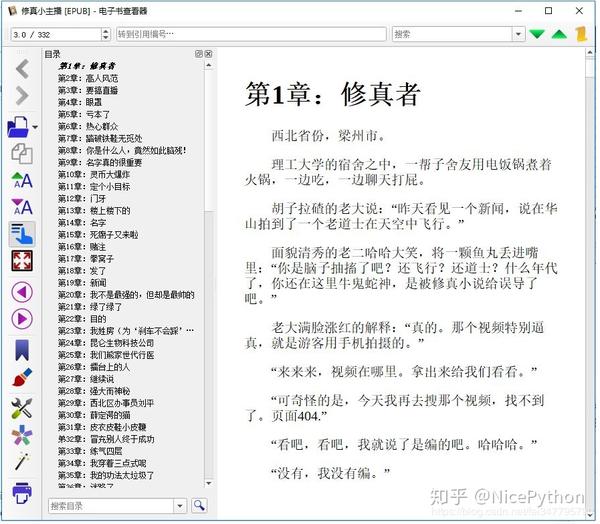

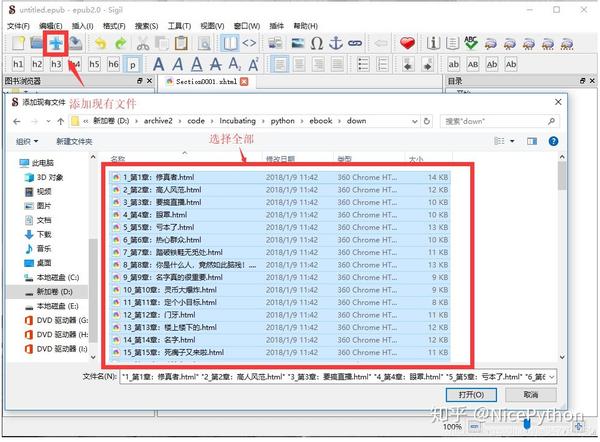

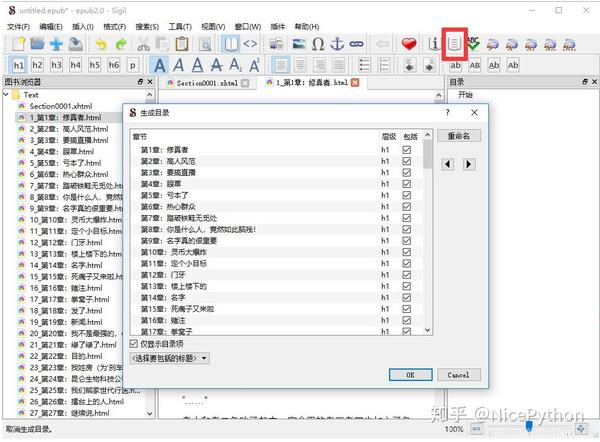

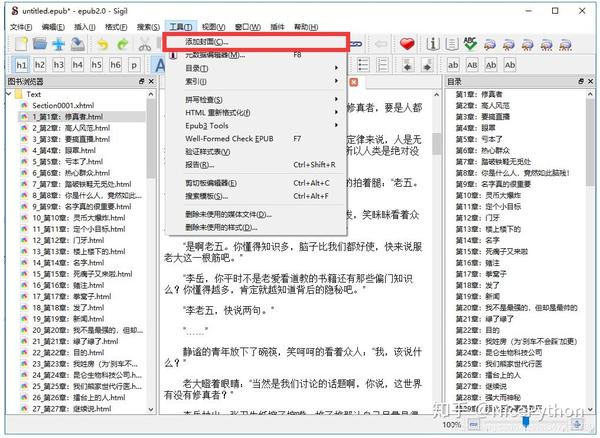

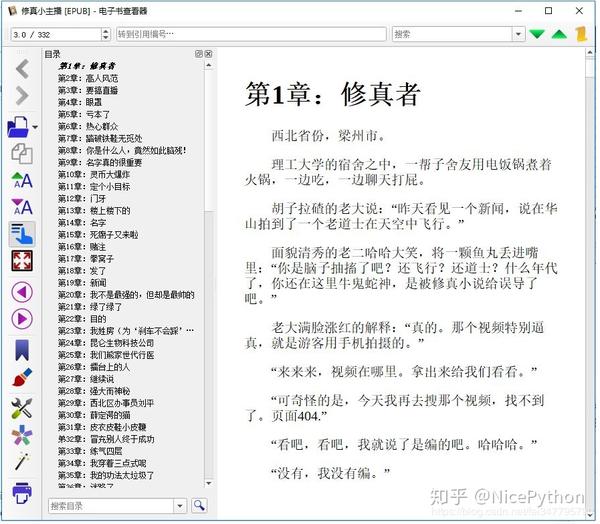

用Sigil制作电子书

加载HTML文件

要制作ePub电子书,我们首先通过Sigil将捕获的文件加载到程序中,然后在添加文件对话框中选择所有文件:

制作目录

当文件中存在HTML的H标记时,单击generate directory按钮自动生成目录。我们在之前的数据捕获中自动添加了H1标记:

掩护

封面基本上是HTML,可以从页面编辑或爬网。让我们让您自己来实现它

查看全部

抓取网页生成电子书(如何用Python爬取网页制作电子书思路怎么抓取数据?)

作者简介:孙震,软件工程师,长期从事企业信息系统的研发工作。他主要擅长后台业务功能的设计和开发

本文来自作者在gitchat上分享的主题“如何用Python抓取网页以制作电子书”。用scrapy抓取电子书

爬行动物思维

首先,我们需要看看从哪里获得数据。打开秀珍小锚页面,如下图:

有一个目录选项卡。单击此选项卡以查看目录。使用浏览器的元素查看工具,我们可以找到每个章节的目录和相关信息。根据这些信息,我们可以爬到特定页面:

获取章节地址

现在我们打开xzxzb.py文件,它是我们刚刚创建的爬虫程序:

# -*- coding: utf-8 -*-

import scrapy

class XzxzbSpider(scrapy.Spider):

name = 'xzxzb'

allowed_domains = ['qidian.com']

start_urls = ['http://qidian.com/']

def parse(self, response):

pass

start_uuURL是目录地址。爬虫程序将自动爬网此地址,并在下面的解析中处理结果。现在,让我们编写代码来处理目录数据。首先,爬上小说的主页以获取目录列表:

def parse(self, response):

pages = response.xpath('//div[@id="j-catalogWrap"]//ul[@class="cf"]/li')

for page in pages:

url = page.xpath('./child::a/attribute::href').extract()

print url

pass

在网页中获取DOM数据有两种方法,一种是使用CSS选择器,另一种是使用XML XPath查询

这里我们使用XPath。请自行学习相关知识。请看上面的代码。首先,我们通过ID得到目录框,得到类CF,得到目录列表:

pages = response.xpath('//div[@id="j-catalogWrap"]//ul[@class="cf"]/li')

接下来,遍历子节点,在Li标记中查询子节点的href属性,最后将其打印出来:

for page in pages:

url = page.xpath('./child::a/attribute::href').extract()

print url

这样,可以说爬行章节路径的小爬虫已经被编写好了。使用以下命令运行xzzb crawler以查看结果:

scrapy crawl xzxzb

此时,我们的程序中可能会出现以下错误:

…

ImportError: No module named win32api

…

运行以下语句:

pip install pypiwin32

屏幕输出如下所示:

> ...

> [u'//read.qidian.com/chapter/MuRzJqCY6MyoLoerY3WDhg2/wrrduN6auIlOBDFlr9quQA2']

[u'//read.qidian.com/chapter/MuRzJqCY6MyoLoerY3WDhg2/Jh-J5usgyW62uJcMpdsVgA2']

[u'//read.qidian.com/chapter/MuRzJqCY6MyoLoerY3WDhg2/5YXHdBvg1ImaGfXRMrUjdw2']

[u'//read.qidian.com/chapter/MuRzJqCY6MyoLoerY3WDhg2/fw5EBeKat-76ItTi_ILQ7A2']

[u'//read.qidian.com/chapter/MuRzJqCY6MyoLoerY3WDhg2/KsFh5VutI6PwrjbX3WA1AA2']

[u'//read.qidian.com/chapter/MuRzJqCY6MyoLoerY3WDhg2/-mpKJ01gPp1p4rPq4Fd4KQ2']

[u'//read.qidian.com/chapter/MuRzJqCY6MyoLoerY3WDhg2/MlZSeYOQxSPM5j8_3RRvhw2']

[u'//read.qidian.com/chapter/MuRzJqCY6MyoLoerY3WDhg2/5TXZqGvLi-3M5j8_3RRvhw2']

[u'//read.qidian.com/chapter/MuRzJqCY6MyoLoerY3WDhg2/sysD-JPiugv4p8iEw--PPw2']

[u'//read.qidian.com/chapter/MuRzJqCY6MyoLoerY3WDhg2/xGckZ01j64-aGfXRMrUjdw2']

[u'//read.qidian.com/chapter/MuRzJqCY6MyoLoerY3WDhg2/72lHOJcgmedOBDFlr9quQA2']

[u'//read.qidian.com/chapter/MuRzJqCY6MyoLoerY3WDhg2/cZkHZEYnPl22uJcMpdsVgA2']

[u'//read.qidian.com/chapter/MuRzJqCY6MyoLoerY3WDhg2/vkNh45O3JsRMs5iq0oQwLQ2']

[u'//read.qidian.com/chapter/MuRzJqCY6MyoLoerY3WDhg2/ge4m8RjJyPH6ItTi_ILQ7A2']

[u'//read.qidian.com/chapter/MuRzJqCY6MyoLoerY3WDhg2/Y33PuxrKT4dp4rPq4Fd4KQ2']

[u'//read.qidian.com/chapter/MuRzJqCY6MyoLoerY3WDhg2/MDQznkrkiyXwrjbX3WA1AA2']

[u'//read.qidian.com/chapter/MuRzJqCY6MyoLoerY3WDhg2/A2r-YTzWCYj6ItTi_ILQ7A2']

[u'//read.qidian.com/chapter/MuRzJqCY6MyoLoerY3WDhg2/Ng9CuONRKei2uJcMpdsVgA2']

[u'//read.qidian.com/chapter/MuRzJqCY6MyoLoerY3WDhg2/Q_AxWAge14pMs5iq0oQwLQ2']

[u'//read.qidian.com/chapter/MuRzJqCY6MyoLoerY3WDhg2/ZJshvAu8TVVp4rPq4Fd4KQ2']

[u'//read.qidian.com/chapter/MuRzJqCY6MyoLoerY3WDhg2/hYD2P4c5UB2aGfXRMrUjdw2']

[u'//read.qidian.com/chapter/MuRzJqCY6MyoLoerY3WDhg2/muxiWf_jpqTgn4SMoDUcDQ2']

[u'//read.qidian.com/chapter/MuRzJqCY6MyoLoerY3WDhg2/OQQ5jbADJjVp4rPq4Fd4KQ2']

> ...

对章节路径进行爬网的小爬虫已经编写完成,但我们的目的不仅仅是为了实现这一点,我们接下来将使用这些地址来抓取内容:

章页分析

接下来,让我们分析章节页面。从章节页面,我们想要得到标题和内容

如果章节信息爬行使用parser方法,我们可以编写一个方法来爬行每个章节内容,例如parser_uuChapter,首先查看章节页面的详细信息:

您可以看到,本章的全部内容都在div标记中,类名为main text wrap,标题是类名为J_u,是chaptername的H3标记。具体内容是类名为readcontent的readcontent J_uDiv标记

请尝试将此打印出来:

# -*- coding: utf-8 -*-

import scrapy

class XzxzbSpider(scrapy.Spider):

name = 'xzxzb'

allowed_domains = ['qidian.com']

start_urls = ['https://book.qidian.com/info/1010780117/']

def parse(self, response):

pages = response.xpath('//div[@id="j-catalogWrap"]//ul[@class="cf"]/li')

for page in pages:

url = page.xpath('./child::a/attribute::href').extract_first()

# yield scrapy.Request('https:' + url, callback=self.parse_chapter)

yield response.follow(url, callback=self.parse_chapter)

pass

def parse_chapter(self, response):

title = response.xpath('//div[@class="main-text-wrap"]//h3[@class="j_chapterName"]/text()').extract_first().strip()

content = response.xpath('//div[@class="main-text-wrap"]//div[@class="read-content j_readContent"]').extract_first().strip()

print title

# print content

pass

在上一步中,我们获得了一个章节地址,这是输出内容的相对路径,因此我们使用yield response.follow(URL,callback=self.Parse_chapter)。第二个参数是处理章节页面的回调函数。爬网到章节页面后,我们解析页面并将标题保存到文件中

next_page = response.urljoin(url)

yield scrapy.Request(next_page, callback=self.parse_chapter)

与response.follow不同,绝对路径需要通过相对路径构建。Response.follow可以直接使用相对路径,因此不需要调用urljoin方法

请注意,response.follow直接返回一个请求实例,该实例可以通过yield直接返回

获得数据后,将其存储。因为我们想要一个HTML页面,所以我们可以根据标题来存储它。代码如下:

def parse_chapter(self, response):

title = response.xpath('//div[@class="main-text-wrap"]//h3[@class="j_chapterName"]/text()').extract_first().strip()

content = response.xpath('//div[@class="main-text-wrap"]//div[@class="read-content j_readContent"]').extract_first().strip()

# print title

# print content

filename = './down/%s.html' % (title)

with open(filename, 'wb') as f:

f.write(content.encode('utf-8'))

pass

到目前为止,我们已成功捕获数据,但无法直接使用。需要对其进行分类和优化

数据排序

首先,我们爬下来的章节和页面的排序不是很好。如果我们手工安排,需要花费太多的时间和精力;另外,章节内容收录很多附加内容,阅读体验不好。我们需要优化内容的排版和可读性

让我们先把章节排好。因为目录中的章节列表是按顺序排列的,所以我们只需要在下载页面的名称中添加一个序列号

但是保存网页的代码是一个回调函数。只有在处理目录时才能确定顺序。回调函数如何知道顺序?因此,我们需要告诉回调函数处理部分的序列号。我们需要将参数传递给回调函数。修改后的代码如下:

def parse(self, response):

pages = response.xpath('//div[@id="j-catalogWrap"]//ul[@class="cf"]/li')

for page in pages:

url = page.xpath('./child::a/attribute::href').extract_first()

idx = page.xpath('./attribute::data-rid').extract_first()

# yield scrapy.Request('https:' + url, callback=self.parse_chapter)

req = response.follow(url, callback=self.parse_chapter)

req.meta['idx'] = idx

yield req

pass

def parse_chapter(self, response):

idx = response.meta['idx']

title = response.xpath('//div[@class="main-text-wrap"]//h3[@class="j_chapterName"]/text()').extract_first().strip()

content = response.xpath('//div[@class="main-text-wrap"]//div[@class="read-content j_readContent"]').extract_first().strip()

# print title

# print content

filename = './down/%s_%s.html' % (idx, title)

cnt = '%s %s' % (title, content)

with open(filename, 'wb') as f:

f.write(cnt.encode('utf-8'))

pass

用Sigil制作电子书

加载HTML文件

要制作ePub电子书,我们首先通过Sigil将捕获的文件加载到程序中,然后在添加文件对话框中选择所有文件:

制作目录

当文件中存在HTML的H标记时,单击generate directory按钮自动生成目录。我们在之前的数据捕获中自动添加了H1标记:

掩护

封面基本上是HTML,可以从页面编辑或爬网。让我们让您自己来实现它

抓取网页生成电子书(2019独角兽企业重金招聘Python工程师标准(图)标准)

网站优化 • 优采云 发表了文章 • 0 个评论 • 105 次浏览 • 2021-09-18 19:06

2019年独角兽企业大量招聘Python工程师燃气轮机

一些学生总是问,在学习了Python的基础知识之后,他们不知道该做些什么来改进。今天,我将给您提供另一个小示例,告诉您哪些小工具可以通过Python和爬虫来完成

在知乎,您一定注意到了一些好的专栏(例如crossin的编程教室)。但如果有一天,你最喜欢的受访者被喷到互联网上,愤怒地被删除,这些好的内容将不会被看到。虽然这是一个小概率事件(但它永远不会发生),但您可以将您关注的专栏导出为电子书,以防下雨天。通过这种方式,您可以脱机阅读它们,而不必担心意外删除

只需要工具和源代码,就可以拉到文章底部获取代码

[最终效果]

运行程序并输入列的ID,即网页地址上的路径:

之后,程序会自动抓取文章,并根据发布时间将其合并并导出为PDF文件

[实施构想]

本程序主要分为三个部分:

抓取文章地址列表列,抓取文章每篇文章的详细信息并将其导出PDF1.抓取列表

在之前的文章crawler基本工具中,掌握它可以解决一半的问题。我介绍了如何分析网页上的请求。根据该方法,我们可以通过开发者工具的网络功能在栏目页面找到详细列表的请求:

https://www.zhihu.com/api/v4/c ... icles

在通过next返回的结果中找到,并且是uuend,我们可以得到下一个列表请求的地址(相当于向下滚动页面的触发效果),并判断我们是否得到了所有文章

数据中的ID、标题和URL就是我们需要的数据。因为URL可以通过ID来拼写,所以它不会保存在我们的代码中

使用while循环,直到所有文章ID和标题都被捕获并保存在文件中

while True:

resp = requests.get(url, headers=headers)

j = resp.json()

data = j['data']

for article in data:

# 保存id和title(略)

if j['paging']['is_end']:

break

url = j['paging']['next']

# 按 id 排序(略)

# 导入文件(略)

2.grab文章

对于所有的文章id/url,后续的爬行过程非常简单文章post-richtext的标签中收录了主要内容

一些文本处理需要一些努力。例如,原创页面的图像效果将添加noscript标记和属性,如data actual和Src=“data:image。我们必须删除它们才能正常显示

url = 'https://zhuanlan.zhihu.com/p/' + id

html = requests.get(url, headers=headers).text

soup = BeautifulSoup(html, 'lxml')

content = soup.find(class_='Post-RichText').prettify()

# 对content做处理(略)

with open(file_name, 'w') as f:

f.write(content)

在此步骤中,所有内容都已捕获,可以在本地读取

3.export pdf

为了便于阅读,我们使用wkhtmltopdf+pdfkit将这些HTML文件打包成PDF

Wkhtmltopdf是一个HTML到PDF的工具,需要单独安装。有关详细信息,请访问其官方网站

Pdfkit是由该工具封装的python库,可从PIP安装:

pip install pdfkit

易于使用:

# 获取htmls文件名列表(略)

pdfkit.from_file(sorted(htmls), 'zhihu.pdf')

这就完成了整个列的导出

不仅是知乎列,而且几乎大多数信息类型网站都使用1.grab list2.获取采集数据的详细信息。因此,此代码可以在许多其他网站中使用,只需稍加修改。但是,有些网站需要在登录后访问,因此需要设置标头中的cookie信息。在另外,端口接收到的网站请求不同,参数和限制也不同,因此仍需分析具体问题

关于开发这些爬行动物的小贴士可以在我们的爬行动物战斗课程中学习。如有必要,请在正式帐户中回复爬行动物

[源代码获取]

获取知乎列下载程序源代码,请回复关键字知乎

在官方帐户中(Crossin编程教室)

除了代码外,还提供了本专栏的打包PDF。欢迎阅读和分享

════

其他文章和答案:

欢迎来到搜索和跟随:crossin的编程教室

转载于: 查看全部

抓取网页生成电子书(2019独角兽企业重金招聘Python工程师标准(图)标准)

2019年独角兽企业大量招聘Python工程师燃气轮机

一些学生总是问,在学习了Python的基础知识之后,他们不知道该做些什么来改进。今天,我将给您提供另一个小示例,告诉您哪些小工具可以通过Python和爬虫来完成

在知乎,您一定注意到了一些好的专栏(例如crossin的编程教室)。但如果有一天,你最喜欢的受访者被喷到互联网上,愤怒地被删除,这些好的内容将不会被看到。虽然这是一个小概率事件(但它永远不会发生),但您可以将您关注的专栏导出为电子书,以防下雨天。通过这种方式,您可以脱机阅读它们,而不必担心意外删除

只需要工具和源代码,就可以拉到文章底部获取代码

[最终效果]

运行程序并输入列的ID,即网页地址上的路径:

之后,程序会自动抓取文章,并根据发布时间将其合并并导出为PDF文件

[实施构想]

本程序主要分为三个部分:

抓取文章地址列表列,抓取文章每篇文章的详细信息并将其导出PDF1.抓取列表

在之前的文章crawler基本工具中,掌握它可以解决一半的问题。我介绍了如何分析网页上的请求。根据该方法,我们可以通过开发者工具的网络功能在栏目页面找到详细列表的请求:

https://www.zhihu.com/api/v4/c ... icles

在通过next返回的结果中找到,并且是uuend,我们可以得到下一个列表请求的地址(相当于向下滚动页面的触发效果),并判断我们是否得到了所有文章

数据中的ID、标题和URL就是我们需要的数据。因为URL可以通过ID来拼写,所以它不会保存在我们的代码中

使用while循环,直到所有文章ID和标题都被捕获并保存在文件中

while True:

resp = requests.get(url, headers=headers)

j = resp.json()

data = j['data']

for article in data:

# 保存id和title(略)

if j['paging']['is_end']:

break

url = j['paging']['next']

# 按 id 排序(略)

# 导入文件(略)

2.grab文章

对于所有的文章id/url,后续的爬行过程非常简单文章post-richtext的标签中收录了主要内容

一些文本处理需要一些努力。例如,原创页面的图像效果将添加noscript标记和属性,如data actual和Src=“data:image。我们必须删除它们才能正常显示

url = 'https://zhuanlan.zhihu.com/p/' + id