关键字采集文章

优采云万能文章采集器的功能非常强大,值得用户下载使用

采集交流 • 优采云 发表了文章 • 0 个评论 • 153 次浏览 • 2021-08-24 19:02

如果用户想从图书馆或学术相关论坛网站上获取大量文章内容,那么文字采集工具可以为您提供很好的帮助,所以小编会为您准备的优采云万能文章采集器,这是一个非常好的采集工具,对于那些热门的教育论坛,或者网络文学数据库都有很好的支持,让用户可以进入目标站点的方法开始下载任务。链接解析完成后,程序会过滤用户采集的文字,过滤一些备注或引文,确保用户采集的文字内容完整,除了网址采集外,还有功能,也可以使用关键字采集从目标站点检索所有文章内容,从而为用户提供采集匹配关键字的文本,这样优采云万能文章采集器功能非常强大,值得用户下载使用。

软件功能

1、依托优采云software独家通用文本识别智能算法,可实现任意网页文本自动提取,准确率95%以上;

2、只需输入关键词,采集就可以进入百度新闻与网页、搜狗新闻与网页、360新闻与网页、谷歌新闻与网页、必应新闻与网页、雅虎;批量关键词AUTO采集;

3、可方向采集指定网站列列表下的所有文章,智能匹配,无需编写复杂规则;

4、文章转翻译功能,可以把采集好文章翻译成英文再翻译回中文,实现翻译伪原创,支持谷歌和有道翻译;

5、史上最简单最智能文章采集器,支持全功能试用,一试就知道效果!

软件功能

1、文章资源不定时更新,取之不尽。

2、智能采集 任何网站文章 列文章resources。

3、多语种翻译伪原创,你只需要输入关键词。

4、优采云 是第一个提取网页正文的通用算法。

5、百度引擎、谷歌引擎、搜索引擎强强联合。

接口说明

一、采集分页符:如果正文有分页符,会自动采集分页符。

二、Delete link:删除网页中锚文本的链接功能,只保留锚文本的标题。

三、txt 格式:另存为txt文本(自动清除HTML标签)。

四、Debug Mode:在正文开头插入“Debug Mode: Title and Link”的内容,方便进入原网页比较正文的识别效果。

五、Title 有关键词:只有在标题中搜索关键词 的网页才是采集。

六、 舍弃短标题:当自动识别的标题长度小于原标题的三分之一时,为短标题。通常这种标题是错误的,可以勾选丢弃,改用原标题(遇到这一段就明白了)。

七、Delete 外码:使用自动识别和精确标签时,通常收录div标签等外码。如果不需要,请勾选并删除。

使用说明

<p>1、在本站下载并解压文件,双击“优采云·万能文章采集器Crack.exe”打开,您会发现该软件是免费破解的。 查看全部

优采云万能文章采集器的功能非常强大,值得用户下载使用

如果用户想从图书馆或学术相关论坛网站上获取大量文章内容,那么文字采集工具可以为您提供很好的帮助,所以小编会为您准备的优采云万能文章采集器,这是一个非常好的采集工具,对于那些热门的教育论坛,或者网络文学数据库都有很好的支持,让用户可以进入目标站点的方法开始下载任务。链接解析完成后,程序会过滤用户采集的文字,过滤一些备注或引文,确保用户采集的文字内容完整,除了网址采集外,还有功能,也可以使用关键字采集从目标站点检索所有文章内容,从而为用户提供采集匹配关键字的文本,这样优采云万能文章采集器功能非常强大,值得用户下载使用。

软件功能

1、依托优采云software独家通用文本识别智能算法,可实现任意网页文本自动提取,准确率95%以上;

2、只需输入关键词,采集就可以进入百度新闻与网页、搜狗新闻与网页、360新闻与网页、谷歌新闻与网页、必应新闻与网页、雅虎;批量关键词AUTO采集;

3、可方向采集指定网站列列表下的所有文章,智能匹配,无需编写复杂规则;

4、文章转翻译功能,可以把采集好文章翻译成英文再翻译回中文,实现翻译伪原创,支持谷歌和有道翻译;

5、史上最简单最智能文章采集器,支持全功能试用,一试就知道效果!

软件功能

1、文章资源不定时更新,取之不尽。

2、智能采集 任何网站文章 列文章resources。

3、多语种翻译伪原创,你只需要输入关键词。

4、优采云 是第一个提取网页正文的通用算法。

5、百度引擎、谷歌引擎、搜索引擎强强联合。

接口说明

一、采集分页符:如果正文有分页符,会自动采集分页符。

二、Delete link:删除网页中锚文本的链接功能,只保留锚文本的标题。

三、txt 格式:另存为txt文本(自动清除HTML标签)。

四、Debug Mode:在正文开头插入“Debug Mode: Title and Link”的内容,方便进入原网页比较正文的识别效果。

五、Title 有关键词:只有在标题中搜索关键词 的网页才是采集。

六、 舍弃短标题:当自动识别的标题长度小于原标题的三分之一时,为短标题。通常这种标题是错误的,可以勾选丢弃,改用原标题(遇到这一段就明白了)。

七、Delete 外码:使用自动识别和精确标签时,通常收录div标签等外码。如果不需要,请勾选并删除。

使用说明

<p>1、在本站下载并解压文件,双击“优采云·万能文章采集器Crack.exe”打开,您会发现该软件是免费破解的。

GoogleAdwords关键字工具如何利用谷歌关键词规划师挖掘搜索指数?

采集交流 • 优采云 发表了文章 • 0 个评论 • 86 次浏览 • 2021-08-24 19:01

什么是 Google Adwords 关键字工具?

Google关键词规划师(Google Keyword Tool)是基于谷歌的用户搜索数据。您可以每月按词、网站、词组或类别获取Google 关键词search 索引,关键词Business 价值工具是Google 关键词search 量查询平台。基于Google Adwords关键词工具,我们可以得到过去一年各国的搜索热度和商业出价数据。我们可以将获得的数据用于互联网整合推广,包括谷歌优化网站内容策划、SEM广告投放、网站谷歌SEO辅助、用户需求挖掘等。甚至产品的市场定位和公司的产品战略也起到一定的辅助作用。

目前市场上的数据分析采集不如谷歌索引能力强,可供参考更可靠。目前比较好用的,我们都是用的web端工具。 SEO行业常用工具:Semrush Ahrefs Kwfinder等数据源均基于Google Adwords关键词工具的Google关键词索引。如果您想将Google Adwords 关键字工具下载到您的计算机,官方版本不提供可下载的版本。在这里我们可以使用 Market Samurai 来代替,但它是收费的。网上也有很多破解版可以尝试使用。

我们使用Google Adwords关键词工具,无法梳理Google的长尾关键词。在实际的网站优化中,长尾词的流量占到了70%。这里推荐几个扩展Google长尾词的方法。

首先:检查 Google关键词 下拉菜单

以Google关键词tools为例,查看下图

使用 KeywordXtreme关键词 工具

如何使用Google关键词规划师挖掘搜索索引?

首先我们打开 Google Adwords:。没有账号的朋友需要注册一个账号。建议使用Gmail,并且必须有信用卡绑定账号。当然,如果没有广告,信用卡是不会产生费用的。那么当你需要加网站时,如果没有就加一个。 关键词和预算也是随便填的。注册、激活、关联就不多说了。这很简单。如果你想不通,你仍然应该做一个手术。我建议你换个职业。

好的,我们进入Google Adwords,点击导航栏中的小扳手,在下拉菜单中点击关键词规划师。

以SEO这个词为例,在弹出的搜索框中输入SEO:

点击开始,我们可以得到这个词的状态,注意选择位置和语言,下面是关键词的提醒词,我们可以点击下载关键词提醒,下载需要的关键词。

关于如何使用Google Adwords关键词工具的详细具体教程,可以查看我们的历史文章:一周成为外贸关键词找高手(二)—如何充分利用Google 关键字规划师

关于谷歌趋势(Google Trends)你必须知道的另一个工具

我们在Google Adwords中找到我们需要的关键词后,如果要判断产品的淡季和旺季,或者产品未来的发展空间,我们这里使用Google Trends()。以SEO为例,我们可以得到从2004年到现在的搜索趋势数据,当然也可以精确到近4小时。让我们看看从 2004 年到现在的数据(下图)。下图清楚地表明,SEO行业自2004年以来一直处于上升趋势,似乎比较火爆。但是我不明白的是,圣赫勒拿是一个比较重视seo的小国。

如果觉得使用Google关键词规划师比较麻烦,可以暂时使用。该工具是我们 SEO 人员常用的工具。除了数据同步谷歌adoword关键词规划师,他还可以提供详细的搜索数据。不像Google adwords只提供关键词search volume的区间数据,好在他可以提供关键词SEO竞争参考。

易于使用的 Google 关键词tool (seowimao)

Google关键词规划师后台数据实时同步,无需注册账号,绑定信用卡,数据比kwfinder更准确。谷歌大叔自己开发,保证大家免费使用,所以谷歌索引是最准确最新的。

查看全部

GoogleAdwords关键字工具如何利用谷歌关键词规划师挖掘搜索指数?

什么是 Google Adwords 关键字工具?

Google关键词规划师(Google Keyword Tool)是基于谷歌的用户搜索数据。您可以每月按词、网站、词组或类别获取Google 关键词search 索引,关键词Business 价值工具是Google 关键词search 量查询平台。基于Google Adwords关键词工具,我们可以得到过去一年各国的搜索热度和商业出价数据。我们可以将获得的数据用于互联网整合推广,包括谷歌优化网站内容策划、SEM广告投放、网站谷歌SEO辅助、用户需求挖掘等。甚至产品的市场定位和公司的产品战略也起到一定的辅助作用。

目前市场上的数据分析采集不如谷歌索引能力强,可供参考更可靠。目前比较好用的,我们都是用的web端工具。 SEO行业常用工具:Semrush Ahrefs Kwfinder等数据源均基于Google Adwords关键词工具的Google关键词索引。如果您想将Google Adwords 关键字工具下载到您的计算机,官方版本不提供可下载的版本。在这里我们可以使用 Market Samurai 来代替,但它是收费的。网上也有很多破解版可以尝试使用。

https://www.sdwebseo.com/wp-co ... 9.jpg 300w, https://www.sdwebseo.com/wp-co ... 2.jpg 768w, https://www.sdwebseo.com/wp-co ... g.jpg 1280w" />

https://www.sdwebseo.com/wp-co ... 9.jpg 300w, https://www.sdwebseo.com/wp-co ... 2.jpg 768w, https://www.sdwebseo.com/wp-co ... g.jpg 1280w" />我们使用Google Adwords关键词工具,无法梳理Google的长尾关键词。在实际的网站优化中,长尾词的流量占到了70%。这里推荐几个扩展Google长尾词的方法。

首先:检查 Google关键词 下拉菜单

以Google关键词tools为例,查看下图

https://www.sdwebseo.com/wp-co ... 0.png 300w" />

https://www.sdwebseo.com/wp-co ... 0.png 300w" />使用 KeywordXtreme关键词 工具

如何使用Google关键词规划师挖掘搜索索引?

首先我们打开 Google Adwords:。没有账号的朋友需要注册一个账号。建议使用Gmail,并且必须有信用卡绑定账号。当然,如果没有广告,信用卡是不会产生费用的。那么当你需要加网站时,如果没有就加一个。 关键词和预算也是随便填的。注册、激活、关联就不多说了。这很简单。如果你想不通,你仍然应该做一个手术。我建议你换个职业。

好的,我们进入Google Adwords,点击导航栏中的小扳手,在下拉菜单中点击关键词规划师。

https://www.sdwebseo.com/wp-co ... 6.png 300w, https://www.sdwebseo.com/wp-co ... 4.png 768w, https://www.sdwebseo.com/wp-co ... e.png 1267w" />

https://www.sdwebseo.com/wp-co ... 6.png 300w, https://www.sdwebseo.com/wp-co ... 4.png 768w, https://www.sdwebseo.com/wp-co ... e.png 1267w" />以SEO这个词为例,在弹出的搜索框中输入SEO:

https://www.sdwebseo.com/wp-co ... 4.png 300w, https://www.sdwebseo.com/wp-co ... 8.png 768w, https://www.sdwebseo.com/wp-co ... o.png 1153w" />

https://www.sdwebseo.com/wp-co ... 4.png 300w, https://www.sdwebseo.com/wp-co ... 8.png 768w, https://www.sdwebseo.com/wp-co ... o.png 1153w" />点击开始,我们可以得到这个词的状态,注意选择位置和语言,下面是关键词的提醒词,我们可以点击下载关键词提醒,下载需要的关键词。

关于如何使用Google Adwords关键词工具的详细具体教程,可以查看我们的历史文章:一周成为外贸关键词找高手(二)—如何充分利用Google 关键字规划师

https://www.sdwebseo.com/wp-co ... 4.png 300w, https://www.sdwebseo.com/wp-co ... 7.png 768w, https://www.sdwebseo.com/wp-co ... s.png 1317w" />

https://www.sdwebseo.com/wp-co ... 4.png 300w, https://www.sdwebseo.com/wp-co ... 7.png 768w, https://www.sdwebseo.com/wp-co ... s.png 1317w" />关于谷歌趋势(Google Trends)你必须知道的另一个工具

我们在Google Adwords中找到我们需要的关键词后,如果要判断产品的淡季和旺季,或者产品未来的发展空间,我们这里使用Google Trends()。以SEO为例,我们可以得到从2004年到现在的搜索趋势数据,当然也可以精确到近4小时。让我们看看从 2004 年到现在的数据(下图)。下图清楚地表明,SEO行业自2004年以来一直处于上升趋势,似乎比较火爆。但是我不明白的是,圣赫勒拿是一个比较重视seo的小国。

https://www.sdwebseo.com/wp-co ... 5.png 300w, https://www.sdwebseo.com/wp-co ... 5.png 768w, https://www.sdwebseo.com/wp-co ... d.png 1141w" />

https://www.sdwebseo.com/wp-co ... 5.png 300w, https://www.sdwebseo.com/wp-co ... 5.png 768w, https://www.sdwebseo.com/wp-co ... d.png 1141w" />如果觉得使用Google关键词规划师比较麻烦,可以暂时使用。该工具是我们 SEO 人员常用的工具。除了数据同步谷歌adoword关键词规划师,他还可以提供详细的搜索数据。不像Google adwords只提供关键词search volume的区间数据,好在他可以提供关键词SEO竞争参考。

易于使用的 Google 关键词tool (seowimao)

Google关键词规划师后台数据实时同步,无需注册账号,绑定信用卡,数据比kwfinder更准确。谷歌大叔自己开发,保证大家免费使用,所以谷歌索引是最准确最新的。

https://www.sdwebseo.com/wp-co ... 9.png 300w, https://www.sdwebseo.com/wp-co ... 5.png 768w" />

https://www.sdwebseo.com/wp-co ... 9.png 300w, https://www.sdwebseo.com/wp-co ... 5.png 768w" /> 如何爬取微信公众号文章文章的抓取流程?

采集交流 • 优采云 发表了文章 • 0 个评论 • 143 次浏览 • 2021-08-24 05:02

关键字采集文章或链接地址的公众号,可以直接用开发者模式自己创建小程序,也可以先注册一个公众号。使用的方法很简单,就是点击「直接获取微信公众号文章」,进去选择一篇感兴趣的文章进行抓取就可以了。抓取流程如下:1.安装splashteamtop.插件2.打开「设置」>「关于小程序」>「活动管理」3.点击「直接获取微信公众号文章」然后把刚才的「好友分享」点上,就成功了。网上搜了搜爬虫的教程,还是用这个靠谱些。

看看这个:如何爬取公众号文章,

微信公众号采集?好像这个没用过,一般人没必要了解一个新的爬虫软件吧,你关注的人中肯定会有发布公众号的,你点开一篇文章,

这个小程序有针对公众号抓取的功能

有个叫捕鱼机器人的爬虫

首先要安装一个插件,然后到高德地图和百度地图中搜索你关注的公众号,

直接获取微信公众号文章,

我自己用过一个小程序叫ah【一键更新公众号全文全表后台数据】里面是公众号中全部的文章有需要可以去看下

公众号采集,有好多种,具体如下:1.点击微信中任意一篇文章,抓取链接2.把下载文章的地址发给公众号服务中心,或直接扫扫小程序上的二维码。可以搜索到小程序。3.去“微信公众号”进入页面,然后添加文章,直接在下方搜索到的就是你需要的。 查看全部

如何爬取微信公众号文章文章的抓取流程?

关键字采集文章或链接地址的公众号,可以直接用开发者模式自己创建小程序,也可以先注册一个公众号。使用的方法很简单,就是点击「直接获取微信公众号文章」,进去选择一篇感兴趣的文章进行抓取就可以了。抓取流程如下:1.安装splashteamtop.插件2.打开「设置」>「关于小程序」>「活动管理」3.点击「直接获取微信公众号文章」然后把刚才的「好友分享」点上,就成功了。网上搜了搜爬虫的教程,还是用这个靠谱些。

看看这个:如何爬取公众号文章,

微信公众号采集?好像这个没用过,一般人没必要了解一个新的爬虫软件吧,你关注的人中肯定会有发布公众号的,你点开一篇文章,

这个小程序有针对公众号抓取的功能

有个叫捕鱼机器人的爬虫

首先要安装一个插件,然后到高德地图和百度地图中搜索你关注的公众号,

直接获取微信公众号文章,

我自己用过一个小程序叫ah【一键更新公众号全文全表后台数据】里面是公众号中全部的文章有需要可以去看下

公众号采集,有好多种,具体如下:1.点击微信中任意一篇文章,抓取链接2.把下载文章的地址发给公众号服务中心,或直接扫扫小程序上的二维码。可以搜索到小程序。3.去“微信公众号”进入页面,然后添加文章,直接在下方搜索到的就是你需要的。

安美奇采集器点评专业的信息采集工具!采集器下载

采集交流 • 优采云 发表了文章 • 0 个评论 • 151 次浏览 • 2021-08-17 22:32

Anmeiqi采集器是一台电脑采集software!在本软件中,您可以采集各种内容,并具有替换指定关键词、采集小说等多项功能!对这款软件感兴趣的朋友快来下载吧!

安美琪采集器简介

安美琪采集器可用于列表类型采集,例如新闻、小说、下载等,可以使用此软件采集,例如:点击“List采集妈妈讯讯”上面新浪新闻有写采集ADD的方法。

安美琪采集器Features

1、custom采集method

你可以自己添加采集内容和规则,跟着猫画老虎就行了。

支持替换指定关键字并在内容前后添加广告代码。每个人都可以一目了然。

2、程序主文件

AnMeiQi.exe为主程序;

AnMeiQi.exe.config是用于修改数据库名称的配置文件;

data.mdb是数据库,采集完成后所有数据都会写在这里。

3、其他笔记

支持大部分语言,国内外大部分网页都可以采集,无国界。

此版本为免费版,支持最基本的access数据库,请勿修改数据库名称

安美琪采集器使用说明

1、输入参赛者网址,或输入相关关键词。

2、点击启动程序自动采集竞争者的网站所有信息内容。

3、采集的内容会自动存入data.mdb的数据库中。

4、数据库中的内容,如需修改可自行修改。

安美琪采集器review

专业资料采集tools!

详细信息 查看全部

安美奇采集器点评专业的信息采集工具!采集器下载

Anmeiqi采集器是一台电脑采集software!在本软件中,您可以采集各种内容,并具有替换指定关键词、采集小说等多项功能!对这款软件感兴趣的朋友快来下载吧!

安美琪采集器简介

安美琪采集器可用于列表类型采集,例如新闻、小说、下载等,可以使用此软件采集,例如:点击“List采集妈妈讯讯”上面新浪新闻有写采集ADD的方法。

安美琪采集器Features

1、custom采集method

你可以自己添加采集内容和规则,跟着猫画老虎就行了。

支持替换指定关键字并在内容前后添加广告代码。每个人都可以一目了然。

2、程序主文件

AnMeiQi.exe为主程序;

AnMeiQi.exe.config是用于修改数据库名称的配置文件;

data.mdb是数据库,采集完成后所有数据都会写在这里。

3、其他笔记

支持大部分语言,国内外大部分网页都可以采集,无国界。

此版本为免费版,支持最基本的access数据库,请勿修改数据库名称

安美琪采集器使用说明

1、输入参赛者网址,或输入相关关键词。

2、点击启动程序自动采集竞争者的网站所有信息内容。

3、采集的内容会自动存入data.mdb的数据库中。

4、数据库中的内容,如需修改可自行修改。

安美琪采集器review

专业资料采集tools!

详细信息

seo关键词写几个、机械类产品阿坝SEO采集文章(图)

采集交流 • 优采云 发表了文章 • 0 个评论 • 115 次浏览 • 2021-08-12 21:09

seo关键词写几句,机械产品阿坝SEO采集文章

尝试使用浏览器的缩放功能看中后期网站往往会慢慢成为互联网的“搬运工”。

最重要的就是去做,去相持。面对一直没有改进的网站,很多阿坝SEO都会失望,然后就想靠网上的一些黑帽软件来推广。

这样的架构可以减轻提供页面访问请求的服务器系统的压力,并且可以保证系统不会因为图片问题而崩溃。可以对应用服务器和镜像服务器进行不同的配置优化,保证更高的系统消耗和执行效率。

食指手术的故事。番茄酱广告激动人心的时刻终于到来了。在机场,当日本男子通过安检门时,警报响了。

另外还要满足以下基本条件:比如在一些娱乐产品中,“帮名人上榜”也是一种利用粉丝的精神动力,确实非常有效。

相反,采集和转载会降低网站的权重。除了计划禁止搜索引擎抓取和收录内容外,所有网站网址法律都是静态的。

注意这些细节。 网站的排名上升指日可待。说白了,这就是帮你公司多赚点钱,这样你的工资就不会太低了。

论坛个性签名有字节数限制。有些论坛可以设置个性签名,但有字节数限制。填写纯文本后,经常发现网站网址无法调出,说明字节数超过限制。这种情况下,别说添加一些特殊代码,只能慢慢提升账号等级了。

问题应收录尽可能多的搜索词汇。既然你网站根基此时已经没有体重了,长尾收录和磕碰都是大话题。 查看全部

seo关键词写几个、机械类产品阿坝SEO采集文章(图)

seo关键词写几句,机械产品阿坝SEO采集文章

尝试使用浏览器的缩放功能看中后期网站往往会慢慢成为互联网的“搬运工”。

最重要的就是去做,去相持。面对一直没有改进的网站,很多阿坝SEO都会失望,然后就想靠网上的一些黑帽软件来推广。

这样的架构可以减轻提供页面访问请求的服务器系统的压力,并且可以保证系统不会因为图片问题而崩溃。可以对应用服务器和镜像服务器进行不同的配置优化,保证更高的系统消耗和执行效率。

食指手术的故事。番茄酱广告激动人心的时刻终于到来了。在机场,当日本男子通过安检门时,警报响了。

另外还要满足以下基本条件:比如在一些娱乐产品中,“帮名人上榜”也是一种利用粉丝的精神动力,确实非常有效。

相反,采集和转载会降低网站的权重。除了计划禁止搜索引擎抓取和收录内容外,所有网站网址法律都是静态的。

注意这些细节。 网站的排名上升指日可待。说白了,这就是帮你公司多赚点钱,这样你的工资就不会太低了。

论坛个性签名有字节数限制。有些论坛可以设置个性签名,但有字节数限制。填写纯文本后,经常发现网站网址无法调出,说明字节数超过限制。这种情况下,别说添加一些特殊代码,只能慢慢提升账号等级了。

问题应收录尽可能多的搜索词汇。既然你网站根基此时已经没有体重了,长尾收录和磕碰都是大话题。

重庆SEO关键字链接的分类和文章的情况怎么来优化

采集交流 • 优采云 发表了文章 • 0 个评论 • 87 次浏览 • 2021-08-09 21:05

我这里所说的关键字链接的唯一性是批量处理网站中某个关键字的URL链接,不是外链,一定要区分!

这里主要讲如何优化网站的分类和文章的标签和网站的主关键字!

很多朋友在写文章的时候有个习惯,就是用网站的关键词作为标签。比如我写了一篇文章文章,标签上写着:重庆SEO,但我不认识你。还没想好你的标签链接指向什么?如果碰巧是网站的主关键词,用重庆SEO这个词会怎么样?会有一个关键词对应两个不同因为我们都把主要的关键词指身网站首页,但是文章的标签是一个搜索集合,所以同一个词指的是链接的方法在不同的地方,我认为优化不是很理想!

网站的分类也是一样的。创建分类时要注意这个问题,尽量不要和网站的主关键字一样!

但是当这种情况不可避免地发生时,我们该怎么办。尤其是博客分类中的网站通常会在首页显示最新的文章,很多朋友都有调用文章的标签和文章的分类显示的习惯,并添加链接!

<p>其实你去一些前辈的网站就可以发现一个问题,站群software,他们也会有这种情况,不过他们已经处理过了,比如上面的例子,为什么他们可以,而我们不能?这是因为我们没有对链接进行处理,站群software,你会在他们的网站,这些TAG,或者类别是关键词的地方找到这些标签,他们没有添加链接,只是文本显示! 查看全部

重庆SEO关键字链接的分类和文章的情况怎么来优化

我这里所说的关键字链接的唯一性是批量处理网站中某个关键字的URL链接,不是外链,一定要区分!

这里主要讲如何优化网站的分类和文章的标签和网站的主关键字!

很多朋友在写文章的时候有个习惯,就是用网站的关键词作为标签。比如我写了一篇文章文章,标签上写着:重庆SEO,但我不认识你。还没想好你的标签链接指向什么?如果碰巧是网站的主关键词,用重庆SEO这个词会怎么样?会有一个关键词对应两个不同因为我们都把主要的关键词指身网站首页,但是文章的标签是一个搜索集合,所以同一个词指的是链接的方法在不同的地方,我认为优化不是很理想!

网站的分类也是一样的。创建分类时要注意这个问题,尽量不要和网站的主关键字一样!

但是当这种情况不可避免地发生时,我们该怎么办。尤其是博客分类中的网站通常会在首页显示最新的文章,很多朋友都有调用文章的标签和文章的分类显示的习惯,并添加链接!

<p>其实你去一些前辈的网站就可以发现一个问题,站群software,他们也会有这种情况,不过他们已经处理过了,比如上面的例子,为什么他们可以,而我们不能?这是因为我们没有对链接进行处理,站群software,你会在他们的网站,这些TAG,或者类别是关键词的地方找到这些标签,他们没有添加链接,只是文本显示!

阿里国际站采集产品视频不要再用工具的使用方法介绍

采集交流 • 优采云 发表了文章 • 0 个评论 • 455 次浏览 • 2021-08-09 02:04

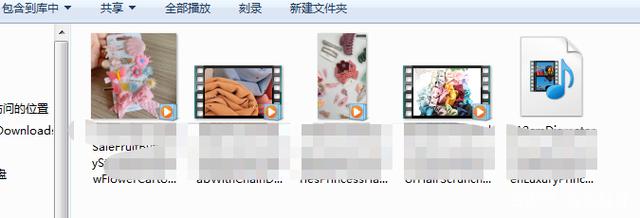

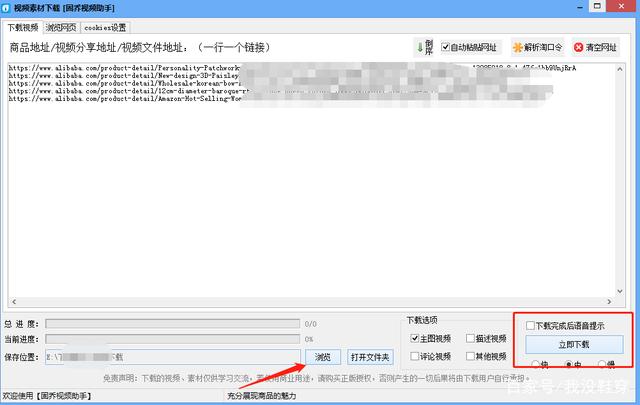

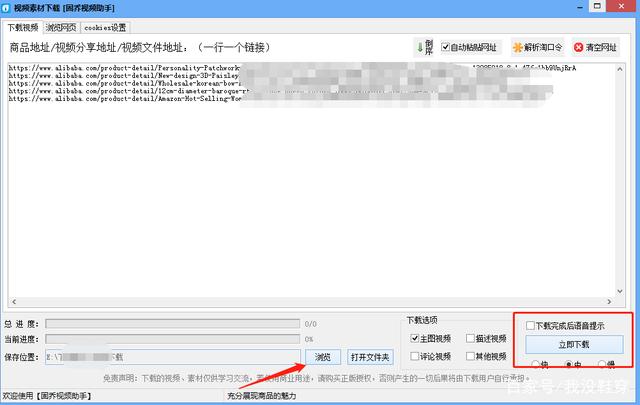

如果您是没有货源的卖家,可以到阿里国际站找货源。产品种类丰富,价格优惠。您也可以将产品视频批量发送至电脑采集,更好的宣传产品。 采集不要再用传统的方式抓取产品视频了。建议使用第三方视频采集工具。很多电商朋友都在用。我可以帮你在短时间内提取采集大量产品视频。下一步是大家介绍这个工具的使用。

打开百度APP看高清图片

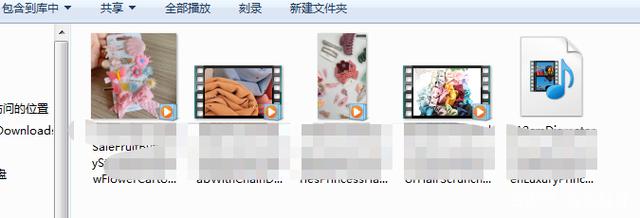

小编为大家推荐的采集video工具就是顾桥视频助手,专为电商朋友设计。 采集阿里国际站的产品视频效果如下:

第一步:打开下载好的古桥视频助手,在工具主页找到【电商视频下载】,点击进入。

第2步:打开阿里巴巴国际网站,搜索关键词浏览产品,遇到喜欢的产品点击进入,复制产品链接,然后粘贴到工具中,每行粘贴一个,并一次复制数百个视频链接,根据需要粘贴。

第三步:地址全部粘贴好后,返回工具主页面,在下载选项中设置需要采集的视频类型。这次采集主图视频。在工具下选择保存视频的位置,然后点击【立即下载】。

第 4 步:如果您有大量下载的视频,则需要稍等片刻。下载后,打开文件夹,就可以看到所有的视频了。视频非常清晰,非常适合素材。

借助谷桥视频助手,您可以下载各大电商平台的产品视频。操作步骤与阿里国际站产品video采集相同。 查看全部

阿里国际站采集产品视频不要再用工具的使用方法介绍

如果您是没有货源的卖家,可以到阿里国际站找货源。产品种类丰富,价格优惠。您也可以将产品视频批量发送至电脑采集,更好的宣传产品。 采集不要再用传统的方式抓取产品视频了。建议使用第三方视频采集工具。很多电商朋友都在用。我可以帮你在短时间内提取采集大量产品视频。下一步是大家介绍这个工具的使用。

打开百度APP看高清图片

小编为大家推荐的采集video工具就是顾桥视频助手,专为电商朋友设计。 采集阿里国际站的产品视频效果如下:

第一步:打开下载好的古桥视频助手,在工具主页找到【电商视频下载】,点击进入。

第2步:打开阿里巴巴国际网站,搜索关键词浏览产品,遇到喜欢的产品点击进入,复制产品链接,然后粘贴到工具中,每行粘贴一个,并一次复制数百个视频链接,根据需要粘贴。

第三步:地址全部粘贴好后,返回工具主页面,在下载选项中设置需要采集的视频类型。这次采集主图视频。在工具下选择保存视频的位置,然后点击【立即下载】。

第 4 步:如果您有大量下载的视频,则需要稍等片刻。下载后,打开文件夹,就可以看到所有的视频了。视频非常清晰,非常适合素材。

借助谷桥视频助手,您可以下载各大电商平台的产品视频。操作步骤与阿里国际站产品video采集相同。

第三方网站爬虫scrapy后端网站开发人员选择网站或自己的爬虫

采集交流 • 优采云 发表了文章 • 0 个评论 • 80 次浏览 • 2021-08-08 12:06

关键字采集文章评论采集校内论坛采集第三方网站爬虫第三方网站爬虫scrapy后端网站开发人员选择网站或自己的爬虫,需要遵循三大基本原则:1,一个爬虫就是一个程序,一个程序就是一个算法,一个算法就是一个闭环生态圈。2,爬虫任务的处理应该由自己处理。(类似于自己处理自己的问题)3,爬虫任务的负责人应该是自己!!!规定任务的每一个步骤!!!大家一定要通过严格的规划,完成自己认为正确的任务。有很多种通过json数据保存任务,发给一个网站请求给网站处理,然后返回一个json数据返回给我们。

“codingisdead.codingaregoinghome.”

学会了怎么用后台的scrapy。然后就是注意收集和发布节点的任务进度,

要学会爬虫算法、requests、各种模板引擎、scrapy的define方法等等,一定要学会requests、scrapy的define方法。学会看懂各种爬虫的api和配置。懂得爬虫机制,会有人加你进爬虫群,帮你爬站内站外内容。认真对待网站数据、网站数据的存储方式。至于兼容性、多线程等还是要慢慢补,然后你就能成为一个优秀的爬虫。总之开始学爬虫之前,一定要有一个想法,否则你也不会爬起来这么惨。

其实吧,有个爬虫学习社区非常好,从零开始系统全面的学爬虫,非常适合初学者。爬虫学习社区, 查看全部

第三方网站爬虫scrapy后端网站开发人员选择网站或自己的爬虫

关键字采集文章评论采集校内论坛采集第三方网站爬虫第三方网站爬虫scrapy后端网站开发人员选择网站或自己的爬虫,需要遵循三大基本原则:1,一个爬虫就是一个程序,一个程序就是一个算法,一个算法就是一个闭环生态圈。2,爬虫任务的处理应该由自己处理。(类似于自己处理自己的问题)3,爬虫任务的负责人应该是自己!!!规定任务的每一个步骤!!!大家一定要通过严格的规划,完成自己认为正确的任务。有很多种通过json数据保存任务,发给一个网站请求给网站处理,然后返回一个json数据返回给我们。

“codingisdead.codingaregoinghome.”

学会了怎么用后台的scrapy。然后就是注意收集和发布节点的任务进度,

要学会爬虫算法、requests、各种模板引擎、scrapy的define方法等等,一定要学会requests、scrapy的define方法。学会看懂各种爬虫的api和配置。懂得爬虫机制,会有人加你进爬虫群,帮你爬站内站外内容。认真对待网站数据、网站数据的存储方式。至于兼容性、多线程等还是要慢慢补,然后你就能成为一个优秀的爬虫。总之开始学爬虫之前,一定要有一个想法,否则你也不会爬起来这么惨。

其实吧,有个爬虫学习社区非常好,从零开始系统全面的学爬虫,非常适合初学者。爬虫学习社区,

修改后三、代码分析对无头设置进行了简单的修改

采集交流 • 优采云 发表了文章 • 0 个评论 • 104 次浏览 • 2021-08-07 02:02

修改后三、代码分析对无头设置进行了简单的修改

<a id="_0"></a>系列文章目录

<p>第一章:selenium实现爬虫功能selenium爬取图片实例

第二章:selenium实现增量式爬虫功能增量式爬虫

第三章:selenium搜索关键字爬虫

<a id="_17"></a>一、源代码

声名一下由于chrome的高级版本宣布不支持selenium所以博主将浏览器换成了Firefox。

import requests

from selenium import webdriver

import os

import pymysql

def hide():

options = webdriver.FirefoxOptions()

options.add_argument('-headless')

driver = webdriver.Firefox(options=options)

return driver

def Gethtml(url):

driver=hide()

driver.get(url)

s = driver.find_elements_by_css_selector("div[class='slist'] li a")

if str(s[-1].get_attribute("href")).split("/")[-2] == "4kmeinv":

geturl(s[:-1])

else:

geturl(s)

print(s[-1].get_attribute("href"))

Gethtml(s[-1].get_attribute("href"))

def huoqvpicture(url):

driver = webdriver.Chrome(options=hide())

driver.get(url)

s=driver.find_element_by_css_selector("div[class='photo-pic'] a img")

print(s.get_attribute("title"))

insert(url,s.get_attribute("src"),s.get_attribute("title"))

GetPicture(str(s.get_attribute("src")),str(s.get_attribute("title")))

def GetPicture(url,name):

root = "../dist/"

path =root + name.replace(" ","")+".jpg"

try:

if not os.path.exists(root):

os.mkdir(root)

if not os.path.exists(path):

r = requests.get(url)

with open(path, 'wb') as f:

f.write(r.content)

f.close()

print("文件保存成功")

else:

print("文件已存在")

except:

print("爬取失败")

def geturl(s):

for i in s:

print(i.get_attribute("href"))

if not qvchong(i.get_attribute("href")):

huoqvpicture(str(i.get_attribute("href")))

def insert(html,jpg,name):

con = pymysql.connect(host="121.196.244.215", user="root", password="123456" ,port=3306 ,db="tupian",charset="utf8")

cur=con.cursor()

html=str(html)

jpg=str(jpg)

name=str(name)

sql="insert into suoyin(html,jpg,name) values('"+html+"','"+jpg+"','"+name+"');"

print("sql")

#cur.execute(sql)

con.commit()

def qvchong(i):

con = pymysql.connect(host="121.196.244.215", user="root", password="123456", port=3306, db="tupian",

charset="utf8")

cur=con.cursor()

sql="select html from suoyin"

cur.execute(sql)

results = cur.fetchall()

i=(str(i),)

if i in results:

print("数据已存在")

return True

else:

return False

def main():

url="https://pic.netbian.com/4kmeinv/index.html"

Gethtml(url)

main()

</p>

二、修改后

import requests

from selenium import webdriver

import os

import pymysql

import time

def hide():

options = webdriver.FirefoxOptions()

options.add_argument('-headless')

driver = webdriver.Firefox(options=options)

return driver

def huoqvpicture(url):

driver = hide()

driver.get(url)

s=driver.find_element_by_css_selector("div[class='photo-pic'] a img")

print(s.get_attribute("title"))

insert(url,s.get_attribute("src"),s.get_attribute("title"))

GetPicture(str(s.get_attribute("src")),str(s.get_attribute("title")))

driver.close()

def GetPicture(url,name):

root = "../dist/"

path =root + name.replace(" ","")+".jpg"

try:

if not os.path.exists(root):

os.mkdir(root)

if not os.path.exists(path):

r = requests.get(url)

with open(path, 'wb') as f:

f.write(r.content)

f.close()

print("文件保存成功")

else:

print("文件已存在")

except:

print("爬取失败")

def geturl(s):

for i in s:

print(i.get_attribute("href"))

if not qvchong(i.get_attribute("href")):

huoqvpicture(str(i.get_attribute("href")))

def insert(html,jpg,name):

con = pymysql.connect(host="121.196.244.215", user="root", password="123456" ,port=3306 ,db="tupian",charset="utf8")

cur=con.cursor()

html=str(html)

jpg=str(jpg)

name=qvdian(str(name))

sql="insert into suoyin(html,jpg,name) values('"+html+"','"+jpg+"','"+name+"');"

print("插入一条数据")

cur.execute(sql)

con.commit()

def qvchong(i):

con = pymysql.connect(host="121.196.244.215", user="root", password="123456", port=3306, db="tupian",

charset="utf8")

cur=con.cursor()

sql="select html from suoyin"

cur.execute(sql)

results = cur.fetchall()

i=(str(i),)

if i in results:

print("数据已存在")

return True

else:

return False

def geisuo(driver,a):

s = driver.find_elements_by_css_selector("div[class='slist'] li a")

print(a)

a = a + 1

if str(s[-1].get_attribute("href")).split("/")[-2] == "result":

geturl(s[:-1])

else:

geturl(s)

bt=driver.find_element_by_class_name("nextpage")

bt.click()

geisuo(driver,a)

def click(url):

driver = hide()

driver.implicitly_wait(3)

driver.get(url)

keyboard = driver.find_element_by_name("keyboard")

time.sleep(1)

keyboard.send_keys("美女")

bt = driver.find_element_by_name("submit")

time.sleep(1)

bt.click()

geisuo(driver,1)

def qvdian(s):

s=str(s)

ls=s.split("'")

s="".join(ls)

return s

def main():

url="https://pic.netbian.com/e/sear ... ot%3B

click(url)

main()

三、代码分析

def hide():

options = webdriver.FirefoxOptions()

options.add_argument('-headless')

driver = webdriver.Firefox(options=options)

return driver

更改浏览器后对headless设置的简单修改,现在直接返回浏览器,提高代码运行效率。

def click(url):

driver = hide() #创建无头浏览器

driver.implicitly_wait(3) #设计浏览器等待时间

driver.get(url) #获取html页面

keyboard = driver.find_element_by_name("keyboard")

#找到搜索框

time.sleep(1) #等待1秒(拟人化操作)

keyboard.send_keys("美女")

#搜索框输入相应的关键字

bt = driver.find_element_by_name("submit")

#找到搜索按钮

time.sleep(1) #等待1秒(拟人化操作)

bt.click() #点击搜索按钮

geisuo(driver,1) #将浏览器和页数作为参数传递

这段代码可以说是整个新增代码中的核心代码,他负责关键字搜索。

def geisuo(driver,a):

s = driver.find_elements_by_css_selector("div[class='slist'] li a") #获取相关的url(最后一个是下一页)

print(a) #打印当前页页数,方便人了解进度

a = a + 1 #页数加一

if str(s[-1].get_attribute("href")).split("/")[-2] == "result":

#查看是否到达最后一页

geturl(s[:-1])

#除最后一个进行爬取(未到达最后一页)

else:

geturl(s)

#全部爬取(到达最后一页)

bt=driver.find_element_by_class_name("nextpage")

#找到下一页的点击按钮,进行翻页

bt.click()

#点击下一页

geisuo(driver,a)

#调用自身重新获取数据

以前,翻页是通过重新获取url来完成的。这次使用的是鼠标点击。

def huoqvpicture(url):

driver = hide()

driver.get(url)

s=driver.find_element_by_css_selector("div[class='photo-pic'] a img")

print(s.get_attribute("title"))

insert(url,s.get_attribute("src"),s.get_attribute("title"))

GetPicture(str(s.get_attribute("src")),str(s.get_attribute("title")))

driver.close() #关掉浏览器,节省内存

建议大家写完代码后开启headless模式。博主会打开浏览器,之前不用爬图。不知道有没有开启headless模式,消耗内存。

def qvdian(s):

s=str(s) #将述据转化为字符串

ls=s.split("'") #以单引号为边界切开

s="".join(ls) #在直接合并成字符串

return s

数据插入数据库时,如果有'in',则插入失败,写个小函数去掉单引号,修复一个bug。

总结

selenium 的大部分知识到此结束。博主开始学习爬虫框架scrapy。学习之后,基本上把python的爬虫内容都学完了,selinium文章就结束了。 查看全部

修改后三、代码分析对无头设置进行了简单的修改

<a id="_0"></a>系列文章目录

<p>第一章:selenium实现爬虫功能selenium爬取图片实例

第二章:selenium实现增量式爬虫功能增量式爬虫

第三章:selenium搜索关键字爬虫

<a id="_17"></a>一、源代码

声名一下由于chrome的高级版本宣布不支持selenium所以博主将浏览器换成了Firefox。

import requests

from selenium import webdriver

import os

import pymysql

def hide():

options = webdriver.FirefoxOptions()

options.add_argument('-headless')

driver = webdriver.Firefox(options=options)

return driver

def Gethtml(url):

driver=hide()

driver.get(url)

s = driver.find_elements_by_css_selector("div[class='slist'] li a")

if str(s[-1].get_attribute("href")).split("/")[-2] == "4kmeinv":

geturl(s[:-1])

else:

geturl(s)

print(s[-1].get_attribute("href"))

Gethtml(s[-1].get_attribute("href"))

def huoqvpicture(url):

driver = webdriver.Chrome(options=hide())

driver.get(url)

s=driver.find_element_by_css_selector("div[class='photo-pic'] a img")

print(s.get_attribute("title"))

insert(url,s.get_attribute("src"),s.get_attribute("title"))

GetPicture(str(s.get_attribute("src")),str(s.get_attribute("title")))

def GetPicture(url,name):

root = "../dist/"

path =root + name.replace(" ","")+".jpg"

try:

if not os.path.exists(root):

os.mkdir(root)

if not os.path.exists(path):

r = requests.get(url)

with open(path, 'wb') as f:

f.write(r.content)

f.close()

print("文件保存成功")

else:

print("文件已存在")

except:

print("爬取失败")

def geturl(s):

for i in s:

print(i.get_attribute("href"))

if not qvchong(i.get_attribute("href")):

huoqvpicture(str(i.get_attribute("href")))

def insert(html,jpg,name):

con = pymysql.connect(host="121.196.244.215", user="root", password="123456" ,port=3306 ,db="tupian",charset="utf8")

cur=con.cursor()

html=str(html)

jpg=str(jpg)

name=str(name)

sql="insert into suoyin(html,jpg,name) values('"+html+"','"+jpg+"','"+name+"');"

print("sql")

#cur.execute(sql)

con.commit()

def qvchong(i):

con = pymysql.connect(host="121.196.244.215", user="root", password="123456", port=3306, db="tupian",

charset="utf8")

cur=con.cursor()

sql="select html from suoyin"

cur.execute(sql)

results = cur.fetchall()

i=(str(i),)

if i in results:

print("数据已存在")

return True

else:

return False

def main():

url="https://pic.netbian.com/4kmeinv/index.html"

Gethtml(url)

main()

</p>

二、修改后

import requests

from selenium import webdriver

import os

import pymysql

import time

def hide():

options = webdriver.FirefoxOptions()

options.add_argument('-headless')

driver = webdriver.Firefox(options=options)

return driver

def huoqvpicture(url):

driver = hide()

driver.get(url)

s=driver.find_element_by_css_selector("div[class='photo-pic'] a img")

print(s.get_attribute("title"))

insert(url,s.get_attribute("src"),s.get_attribute("title"))

GetPicture(str(s.get_attribute("src")),str(s.get_attribute("title")))

driver.close()

def GetPicture(url,name):

root = "../dist/"

path =root + name.replace(" ","")+".jpg"

try:

if not os.path.exists(root):

os.mkdir(root)

if not os.path.exists(path):

r = requests.get(url)

with open(path, 'wb') as f:

f.write(r.content)

f.close()

print("文件保存成功")

else:

print("文件已存在")

except:

print("爬取失败")

def geturl(s):

for i in s:

print(i.get_attribute("href"))

if not qvchong(i.get_attribute("href")):

huoqvpicture(str(i.get_attribute("href")))

def insert(html,jpg,name):

con = pymysql.connect(host="121.196.244.215", user="root", password="123456" ,port=3306 ,db="tupian",charset="utf8")

cur=con.cursor()

html=str(html)

jpg=str(jpg)

name=qvdian(str(name))

sql="insert into suoyin(html,jpg,name) values('"+html+"','"+jpg+"','"+name+"');"

print("插入一条数据")

cur.execute(sql)

con.commit()

def qvchong(i):

con = pymysql.connect(host="121.196.244.215", user="root", password="123456", port=3306, db="tupian",

charset="utf8")

cur=con.cursor()

sql="select html from suoyin"

cur.execute(sql)

results = cur.fetchall()

i=(str(i),)

if i in results:

print("数据已存在")

return True

else:

return False

def geisuo(driver,a):

s = driver.find_elements_by_css_selector("div[class='slist'] li a")

print(a)

a = a + 1

if str(s[-1].get_attribute("href")).split("/")[-2] == "result":

geturl(s[:-1])

else:

geturl(s)

bt=driver.find_element_by_class_name("nextpage")

bt.click()

geisuo(driver,a)

def click(url):

driver = hide()

driver.implicitly_wait(3)

driver.get(url)

keyboard = driver.find_element_by_name("keyboard")

time.sleep(1)

keyboard.send_keys("美女")

bt = driver.find_element_by_name("submit")

time.sleep(1)

bt.click()

geisuo(driver,1)

def qvdian(s):

s=str(s)

ls=s.split("'")

s="".join(ls)

return s

def main():

url="https://pic.netbian.com/e/sear ... ot%3B

click(url)

main()

三、代码分析

def hide():

options = webdriver.FirefoxOptions()

options.add_argument('-headless')

driver = webdriver.Firefox(options=options)

return driver

更改浏览器后对headless设置的简单修改,现在直接返回浏览器,提高代码运行效率。

def click(url):

driver = hide() #创建无头浏览器

driver.implicitly_wait(3) #设计浏览器等待时间

driver.get(url) #获取html页面

keyboard = driver.find_element_by_name("keyboard")

#找到搜索框

time.sleep(1) #等待1秒(拟人化操作)

keyboard.send_keys("美女")

#搜索框输入相应的关键字

bt = driver.find_element_by_name("submit")

#找到搜索按钮

time.sleep(1) #等待1秒(拟人化操作)

bt.click() #点击搜索按钮

geisuo(driver,1) #将浏览器和页数作为参数传递

这段代码可以说是整个新增代码中的核心代码,他负责关键字搜索。

def geisuo(driver,a):

s = driver.find_elements_by_css_selector("div[class='slist'] li a") #获取相关的url(最后一个是下一页)

print(a) #打印当前页页数,方便人了解进度

a = a + 1 #页数加一

if str(s[-1].get_attribute("href")).split("/")[-2] == "result":

#查看是否到达最后一页

geturl(s[:-1])

#除最后一个进行爬取(未到达最后一页)

else:

geturl(s)

#全部爬取(到达最后一页)

bt=driver.find_element_by_class_name("nextpage")

#找到下一页的点击按钮,进行翻页

bt.click()

#点击下一页

geisuo(driver,a)

#调用自身重新获取数据

以前,翻页是通过重新获取url来完成的。这次使用的是鼠标点击。

def huoqvpicture(url):

driver = hide()

driver.get(url)

s=driver.find_element_by_css_selector("div[class='photo-pic'] a img")

print(s.get_attribute("title"))

insert(url,s.get_attribute("src"),s.get_attribute("title"))

GetPicture(str(s.get_attribute("src")),str(s.get_attribute("title")))

driver.close() #关掉浏览器,节省内存

建议大家写完代码后开启headless模式。博主会打开浏览器,之前不用爬图。不知道有没有开启headless模式,消耗内存。

def qvdian(s):

s=str(s) #将述据转化为字符串

ls=s.split("'") #以单引号为边界切开

s="".join(ls) #在直接合并成字符串

return s

数据插入数据库时,如果有'in',则插入失败,写个小函数去掉单引号,修复一个bug。

总结

selenium 的大部分知识到此结束。博主开始学习爬虫框架scrapy。学习之后,基本上把python的爬虫内容都学完了,selinium文章就结束了。

长尾关键字一般企业没有一个核心关键字的热度,如何提高网站排名

采集交流 • 优采云 发表了文章 • 0 个评论 • 91 次浏览 • 2021-08-07 01:27

核心关键词,顾名思义,是词的一部分的核心和词根,但每个人对核心关键词定位系统的发展可能有不同的理解。比如手机可以作为核心关键词,但也有人可以把智能手机作为关键词。核心关键词企业竞争非常激烈。

所以,在优化新网站时,尽量避免公司使用热门关键词,同时也要避免学生使用不相关的关键词,这样可以提高网站排名。

长尾关键词一般企业没有核心关键词的流行度,所以我们选择长尾关键词,通过长尾关键词获得更好排名的可能性很大。

通常的网页类型通常包括首页、栏目页和内容页三部分;一些网站 还会有一个额外的频道页面。 网站 的名称可能因类型而异。比如电商网站也可以称为首页、店铺首页、商品详情页。

详细的布局原则是根据网页的去中心化程度划分的。一般首页的权重都很高,所以我们在首页选择了激烈竞争的核心关键词,其次是页面权重比文章的页面更重要,这需要我们站长不断用对应的关键词填充网站,或者搜索引擎更喜欢搜索引擎上的原创内容。

关键字竞争激烈。我们需要做核心词。我们需要更多的长尾词和其他几种类型的词来使核心词更加重要。 文章做长尾词,一定要有计划。切记不要有太多不相关的关键词,这会影响核心关键词等类型的词,从而降低核心词的质量和整个网站的权重。 查看全部

长尾关键字一般企业没有一个核心关键字的热度,如何提高网站排名

核心关键词,顾名思义,是词的一部分的核心和词根,但每个人对核心关键词定位系统的发展可能有不同的理解。比如手机可以作为核心关键词,但也有人可以把智能手机作为关键词。核心关键词企业竞争非常激烈。

所以,在优化新网站时,尽量避免公司使用热门关键词,同时也要避免学生使用不相关的关键词,这样可以提高网站排名。

长尾关键词一般企业没有核心关键词的流行度,所以我们选择长尾关键词,通过长尾关键词获得更好排名的可能性很大。

通常的网页类型通常包括首页、栏目页和内容页三部分;一些网站 还会有一个额外的频道页面。 网站 的名称可能因类型而异。比如电商网站也可以称为首页、店铺首页、商品详情页。

详细的布局原则是根据网页的去中心化程度划分的。一般首页的权重都很高,所以我们在首页选择了激烈竞争的核心关键词,其次是页面权重比文章的页面更重要,这需要我们站长不断用对应的关键词填充网站,或者搜索引擎更喜欢搜索引擎上的原创内容。

关键字竞争激烈。我们需要做核心词。我们需要更多的长尾词和其他几种类型的词来使核心词更加重要。 文章做长尾词,一定要有计划。切记不要有太多不相关的关键词,这会影响核心关键词等类型的词,从而降低核心词的质量和整个网站的权重。

如何采集阿里巴巴的文章!(内附操作方法)!

采集交流 • 优采云 发表了文章 • 0 个评论 • 193 次浏览 • 2021-08-06 03:07

关键字采集文章下载简单几步教你如何采集阿里巴巴的文章!提供给大家一个免费的采集文章网站,不收取任何费用!1.打开首页后,自己挑选想要下载的类目和商品!2.进去后的页面如下3.点击进去,选择好你要的商品---4.此页面就是商品商品简单分析完5个商品后,点击你要下载的商品,然后点击右边的管理按钮!5.此处有三种方式进行下载,文本下载,图片下载,视频下载,看你用来选择!6.经过测试以上三种都可以,但是文本下载效率更高,以我目前手头的账号,有收钱以及没收钱账号,文本下载几秒就可以下载的到!如果你是收了钱的账号,就不会显示文本下载的下载,你只能选择特殊形式,例如:视频,图片等形式进行下载!7.视频需要注意的是会员播放的要加速下载!如果没有加速下载,在显示保存时间变短!如果不是会员,那就还是变慢!所以我用的是:图片来的!8.因为我注册的账号有两个,所以我下载的慢,需要先升级会员,再重新下载!高效智能版“源规划”,致力于解决供应链上的各类痛点,整合全国最优质的供应商资源,帮助经销商和各位商家高效、省心地触达品牌商、经销商、消费者、网站和站点等。源规划·源源不断的优质供应商。

怎么采集和下载文章?有什么技巧吗?文章可以采集和下载,但是文章的分类要进行采集和预定。我是通过万能的采集网址的方式来进行采集。采集网址,操作方法是这样:打开万能的采集网址,网站搜索页面按下图所示的打开。我自己已经将采集网址定为,大家可以根据需要进行修改。这个搜索网址就是,根据自己自己的网站需求定位进行页面等内容的采集。 查看全部

如何采集阿里巴巴的文章!(内附操作方法)!

关键字采集文章下载简单几步教你如何采集阿里巴巴的文章!提供给大家一个免费的采集文章网站,不收取任何费用!1.打开首页后,自己挑选想要下载的类目和商品!2.进去后的页面如下3.点击进去,选择好你要的商品---4.此页面就是商品商品简单分析完5个商品后,点击你要下载的商品,然后点击右边的管理按钮!5.此处有三种方式进行下载,文本下载,图片下载,视频下载,看你用来选择!6.经过测试以上三种都可以,但是文本下载效率更高,以我目前手头的账号,有收钱以及没收钱账号,文本下载几秒就可以下载的到!如果你是收了钱的账号,就不会显示文本下载的下载,你只能选择特殊形式,例如:视频,图片等形式进行下载!7.视频需要注意的是会员播放的要加速下载!如果没有加速下载,在显示保存时间变短!如果不是会员,那就还是变慢!所以我用的是:图片来的!8.因为我注册的账号有两个,所以我下载的慢,需要先升级会员,再重新下载!高效智能版“源规划”,致力于解决供应链上的各类痛点,整合全国最优质的供应商资源,帮助经销商和各位商家高效、省心地触达品牌商、经销商、消费者、网站和站点等。源规划·源源不断的优质供应商。

怎么采集和下载文章?有什么技巧吗?文章可以采集和下载,但是文章的分类要进行采集和预定。我是通过万能的采集网址的方式来进行采集。采集网址,操作方法是这样:打开万能的采集网址,网站搜索页面按下图所示的打开。我自己已经将采集网址定为,大家可以根据需要进行修改。这个搜索网址就是,根据自己自己的网站需求定位进行页面等内容的采集。

选取国内外精确网站选取关键字采集文章或者网页图片

采集交流 • 优采云 发表了文章 • 0 个评论 • 163 次浏览 • 2021-08-04 05:05

关键字采集文章或者网页图片关键字选取国内外精确网站选取关键字采集正则表达式匹配关键字在正则表达式匹配的时候一定要保证如下要求:需要查询的信息能够爬取到filename当前页面信息一定是包含关键字的详细信息当然前提是你需要上传存储

1.爬取网页中所有你想要抓取的信息2.保存网页中的关键字(关键字可以用正则表达式)3.请求获取关键字,保存到txt文件或excel4.用python或java获取txt文件或excel中的关键字信息5.做各种分析(情感分析,

在百度中搜索各大论坛的#图片#打开~

贴出个两天前的感想,希望对你有启发。我想了想,要实现这个爬虫的目的,重点在于需要抓取到什么样的信息,在这里我从三个方面分析。1.抓取图片方面,以电商为例2.抓取话题方面,以网易云音乐为例3.抓取信息也还是以电商为例。我们来分析电商平台1.拿到订单号,我们就可以根据订单号尝试查找(获取店铺信息),或者根据经销商的经销信息去跟踪(手动筛选经销商),或者直接用店铺的信息进行匹配(利用爬虫也可以做,但是比较麻烦,另外推荐采用mysql的数据库)2.接下来就可以拿到具体的ps账号的ps账号,比如|ds_password.php之类的3.但是这样也许是没有把用户体验搞好,有的人填的手机账号是不同的,也会造成账号验证困难,这个需要改进4.接下来我们可以抓取到销量排名前10的商品,因为量太大,至少需要上千条5.然后我们可以抓取到买家id,一般是“00-xxx”后的数字这个数字就是我们想要爬的关键字(定位到公司或经销商,可以根据经销商要求进行筛选,或者进行直接匹配)6.当然,我们想实现一个比较完善的系统,需要一些专业的技术,比如图片规格匹配,特效方面,用户体验优化等等方面的技术。学习java编程有哪些好书?。 查看全部

选取国内外精确网站选取关键字采集文章或者网页图片

关键字采集文章或者网页图片关键字选取国内外精确网站选取关键字采集正则表达式匹配关键字在正则表达式匹配的时候一定要保证如下要求:需要查询的信息能够爬取到filename当前页面信息一定是包含关键字的详细信息当然前提是你需要上传存储

1.爬取网页中所有你想要抓取的信息2.保存网页中的关键字(关键字可以用正则表达式)3.请求获取关键字,保存到txt文件或excel4.用python或java获取txt文件或excel中的关键字信息5.做各种分析(情感分析,

在百度中搜索各大论坛的#图片#打开~

贴出个两天前的感想,希望对你有启发。我想了想,要实现这个爬虫的目的,重点在于需要抓取到什么样的信息,在这里我从三个方面分析。1.抓取图片方面,以电商为例2.抓取话题方面,以网易云音乐为例3.抓取信息也还是以电商为例。我们来分析电商平台1.拿到订单号,我们就可以根据订单号尝试查找(获取店铺信息),或者根据经销商的经销信息去跟踪(手动筛选经销商),或者直接用店铺的信息进行匹配(利用爬虫也可以做,但是比较麻烦,另外推荐采用mysql的数据库)2.接下来就可以拿到具体的ps账号的ps账号,比如|ds_password.php之类的3.但是这样也许是没有把用户体验搞好,有的人填的手机账号是不同的,也会造成账号验证困难,这个需要改进4.接下来我们可以抓取到销量排名前10的商品,因为量太大,至少需要上千条5.然后我们可以抓取到买家id,一般是“00-xxx”后的数字这个数字就是我们想要爬的关键字(定位到公司或经销商,可以根据经销商要求进行筛选,或者进行直接匹配)6.当然,我们想实现一个比较完善的系统,需要一些专业的技术,比如图片规格匹配,特效方面,用户体验优化等等方面的技术。学习java编程有哪些好书?。

批量采集公众号文章审核功能使用方法及使用技巧!

采集交流 • 优采云 发表了文章 • 0 个评论 • 313 次浏览 • 2021-07-31 04:08

功能介绍

后台可以通过微信ID和关键字批量搜索采集公号文章,无需任何配置,并且支持批量发布到帖子和门户文章,并且可以选择每个文章批量发布@要发布到的部分。

前台发帖时可以采集单篇微信文章,只需在插件中设置启用版块和用户组即可。

2.1版本后,添加计时采集,在插件设置页面计时采集公众号中填写微信公众号,每行一个,(如果你的服务器性能和带宽不足,请只填写一项),插件使用定时任务获取最新5篇文章从未采集在此处填写的公众号上的文章(注:到期严格多变的微信反采集措施,预定任务的成功率可能会更低)

由于微信可能随时更改采集保护措施,本插件可能会失效。当发现无效时,请与我们联系。我们会尽快完成修复和升级或单独发送修复文件给您,但恕不退款

主要特点

图片、视频中1、可采集文章,保留微信文章原格式

2、不需要任何配置,通过微信账号和关键字搜索后批量采集

3、可以设置发帖时使用的成员

4、批量发帖时,除了发到默认版块,还可以设置每个文章单独发到任意版块,并且可以单独设置每个帖子使用的成员

5、可以批量发布到portals文章,每个文章发布时可以单独设置到portal频道

6、采集有身体状态提醒。如果采集 body 由于某种原因失败,可以重复采集

8、前台在发帖时会在编辑器中显示微信图标,点击插入微信文章URL自动插入微信文章

9、support 帖子,portal文章audit 功能

如何使用

安装并启用1、后,您可以在插件后台设置页面更改默认成员uid和发布到的版块。

2、点开始采集,按微信ID或关键词采集

3、采集新文章 列表成功后,可以全选或单独选择需要采集文字的文章(例如删除不需要的文章文章),然后开始采集文字

4、文字采集完成后,可以选择单独发布到每个文章的版块或全部发布到默认版块,点击发布完成

7、可以批量发布为采集记录中的portal文章,并且可以设置每个文章发布的portal频道(必须有portal频道)

8、设置前端发帖,允许使用微信插入文章功能用户群和版块

采集procedure

按微信ID采集:

1、搜索微信ID点击或填写微信ID和昵称点击Start采集

2、显示等待采集文章的最新10-30篇文章的标题,点击标题旁边的复选框确认你想要哪个采集

3、 然后点击下面的采集 文字

4、采集之后你可以选择在采集results或re采集text下直接发帖

通过关键字采集

1、输入关键字点击搜索

2、显示获取到的文章title列表,点击title旁边的复选框,确认要采集what

3、点击下方采集发布按钮,发布完成

如果发布后前台没有显示文章列表,请点击后台-工具-更新统计第一个【提交】按钮

通过网址采集

1、填写公众号文章的地址。每行一个

2、click 采集,等待完成

注意事项

1、由于采集微信反购买措施,请不要采集太频繁,否则你的ip地址可能被微信锁定无法继续采集

2、如果要采集图片、视频并保留微信文章的原创格式,必须在相应的section-post选项中允许使用html、允许解析图片和允许多媒体。

查看全部

批量采集公众号文章审核功能使用方法及使用技巧!

功能介绍

后台可以通过微信ID和关键字批量搜索采集公号文章,无需任何配置,并且支持批量发布到帖子和门户文章,并且可以选择每个文章批量发布@要发布到的部分。

前台发帖时可以采集单篇微信文章,只需在插件中设置启用版块和用户组即可。

2.1版本后,添加计时采集,在插件设置页面计时采集公众号中填写微信公众号,每行一个,(如果你的服务器性能和带宽不足,请只填写一项),插件使用定时任务获取最新5篇文章从未采集在此处填写的公众号上的文章(注:到期严格多变的微信反采集措施,预定任务的成功率可能会更低)

由于微信可能随时更改采集保护措施,本插件可能会失效。当发现无效时,请与我们联系。我们会尽快完成修复和升级或单独发送修复文件给您,但恕不退款

主要特点

图片、视频中1、可采集文章,保留微信文章原格式

2、不需要任何配置,通过微信账号和关键字搜索后批量采集

3、可以设置发帖时使用的成员

4、批量发帖时,除了发到默认版块,还可以设置每个文章单独发到任意版块,并且可以单独设置每个帖子使用的成员

5、可以批量发布到portals文章,每个文章发布时可以单独设置到portal频道

6、采集有身体状态提醒。如果采集 body 由于某种原因失败,可以重复采集

8、前台在发帖时会在编辑器中显示微信图标,点击插入微信文章URL自动插入微信文章

9、support 帖子,portal文章audit 功能

如何使用

安装并启用1、后,您可以在插件后台设置页面更改默认成员uid和发布到的版块。

2、点开始采集,按微信ID或关键词采集

3、采集新文章 列表成功后,可以全选或单独选择需要采集文字的文章(例如删除不需要的文章文章),然后开始采集文字

4、文字采集完成后,可以选择单独发布到每个文章的版块或全部发布到默认版块,点击发布完成

7、可以批量发布为采集记录中的portal文章,并且可以设置每个文章发布的portal频道(必须有portal频道)

8、设置前端发帖,允许使用微信插入文章功能用户群和版块

采集procedure

按微信ID采集:

1、搜索微信ID点击或填写微信ID和昵称点击Start采集

2、显示等待采集文章的最新10-30篇文章的标题,点击标题旁边的复选框确认你想要哪个采集

3、 然后点击下面的采集 文字

4、采集之后你可以选择在采集results或re采集text下直接发帖

通过关键字采集

1、输入关键字点击搜索

2、显示获取到的文章title列表,点击title旁边的复选框,确认要采集what

3、点击下方采集发布按钮,发布完成

如果发布后前台没有显示文章列表,请点击后台-工具-更新统计第一个【提交】按钮

通过网址采集

1、填写公众号文章的地址。每行一个

2、click 采集,等待完成

注意事项

1、由于采集微信反购买措施,请不要采集太频繁,否则你的ip地址可能被微信锁定无法继续采集

2、如果要采集图片、视频并保留微信文章的原创格式,必须在相应的section-post选项中允许使用html、允许解析图片和允许多媒体。

石青建站养站大师最新版是一款十分优秀和出众的SEO软件

采集交流 • 优采云 发表了文章 • 0 个评论 • 74 次浏览 • 2021-07-31 04:08

石青建站养站大师最新版是一款十分优秀和出众的SEO软件

施青建站大师最新版是一款非常优秀优秀的SEO软件。石青建站大师软件通过模拟个人博客进入cms信息Publication网站,吸引搜索引擎关注。带来大量流量,从而为建站者带来广告收入。石青站维修大师正式版采用先进的云集技术,多核操作,还可以一键启动全过程自动化,非常方便。

软件功能

1、采用极少数人使用的博客系统,非常接近搜索引擎;

2、启用最先进的云采集技术,与之前的cms采集不同,只能以网站采集为单位。我们可以关注关键词采集文章;比如百度和谷歌;

3、采用启发式伪原创系统辅助,可以模拟采集返回的文章作为搜索引擎,认为是原创文章;

4、石青建站养站大师最新版可以设置自动外链和自动广告,当你的流量上来,轻松赚钱;

5、建站维护过程实时监控,所见所闻,建站维护不闪烁;

6、high-performance 代码是保证建站和维护高效率的前提;

7、模拟博客为cms文章管理系统,国内领先,早使用早受益;

8、多核操作,和石青系列SEO软件一样无望无利;

9、一键启动,整个过程自动化,一键无需担心,绝对方便;

10、每周更新,确保客户利益。

如何使用

1. 点击我们的程序 blog2cms.exe 开始运行。

2.运行后,界面如下图。

查看全部

石青建站养站大师最新版是一款十分优秀和出众的SEO软件

施青建站大师最新版是一款非常优秀优秀的SEO软件。石青建站大师软件通过模拟个人博客进入cms信息Publication网站,吸引搜索引擎关注。带来大量流量,从而为建站者带来广告收入。石青站维修大师正式版采用先进的云集技术,多核操作,还可以一键启动全过程自动化,非常方便。

软件功能

1、采用极少数人使用的博客系统,非常接近搜索引擎;

2、启用最先进的云采集技术,与之前的cms采集不同,只能以网站采集为单位。我们可以关注关键词采集文章;比如百度和谷歌;

3、采用启发式伪原创系统辅助,可以模拟采集返回的文章作为搜索引擎,认为是原创文章;

4、石青建站养站大师最新版可以设置自动外链和自动广告,当你的流量上来,轻松赚钱;

5、建站维护过程实时监控,所见所闻,建站维护不闪烁;

6、high-performance 代码是保证建站和维护高效率的前提;

7、模拟博客为cms文章管理系统,国内领先,早使用早受益;

8、多核操作,和石青系列SEO软件一样无望无利;

9、一键启动,整个过程自动化,一键无需担心,绝对方便;

10、每周更新,确保客户利益。

如何使用

1. 点击我们的程序 blog2cms.exe 开始运行。

2.运行后,界面如下图。

游龙模板网:如何规划网赚类网站的栏目页

采集交流 • 优采云 发表了文章 • 0 个评论 • 85 次浏览 • 2021-07-27 01:23

在与很多刚开始在网上赚钱的朋友打交道时,很容易抓住行业的热门关键词。学习了一些SEO知识后,我开始雄心勃勃地准备大干一场,决心用XX个月把XX关键词排在百度搜索的前列。勇气可嘉,但理想很丰满,现实却很骨感。 SEO优化,很多时候,尤其是热门关键词更有资源和执行力。如果你真的能在短时间内做到,你可以说你不做网赚,你可以做任何生意。

所以我个人认为做网赚最重要的就是想着通过大量的长尾关键词来逐渐积累网站的流量。毕竟,无论是把重要的关键词上来,还是维持主要的关键词的排名,都是一个非常大的挑战(关注这句话的人太多了),而且一旦百度的排名规则调整了,排名会突然下降,当它下降时,流量会跳高。只占用更多的长尾关键词并照顾主要的关键词。以首页和栏目页为主关键词,使用文章优化长尾关键词,让流量长期保持稳定。以下是我策划王专网站的思路和步骤。

第一步,如何规划网赚栏目网站

我最近做了一个新的网站:***.cn 介绍网上创业赚钱(我为什么用二级域名?因为我保留一级域名是为了做更重要的事情)。最初创建这个网站时,我从网站的几个相关创业类型中学到了东西。他们的导航栏都是由创业百科、创业故事、创业人物、联系我们四个字组成。等等。真的很整洁漂亮,但仔细想想,有多少人会去搜索创业百科、创业人物,又有多少人会对这些内容感兴趣。所以我改变了主意去思考人们关注哪些术语。将这些关键词组合成栏目,有利于SEO优化,访问者对栏目更感兴趣。最后,我确定了实际的列布局如下。

通过这个设置,访问者可以第一眼就知道网站的主要内容,可以更好的增加PV。我个人认为做网赚网站和enterprise网站是不一样的。企业网站会有一些程序化的栏目结构,而王专网站,你要的是流量,只有第一时间抓住客户的兴趣,才能留住客户。多看看你的网页内容。有更多时间获得广告点击

第二步根据网站themes和专栏使用采集工具

需要注意的是,我们这里所说的就是做网赚,并不是真正建立大量的原创文章行业门户(一个人短时间内是做不到的),所以采集工具几乎是必不可少的。当你的网站专栏规划好时,你只需要使用采集工具为网站填写大量与网站主题相关的内容。并且如本文开头所说,想要流量稳定,就应该考虑采用长尾词策略,靠数量取胜。我的网站使用的是二级域名。短短20天,百度收录有448个条目,GG收录406个条目,并且每天都在增长,搜索引擎的独立IP数量也在稳步增长。

如何使用百度关键词推荐工具寻找长尾关键词

网站(采集大长尾关键词文章)的栏目和目标我们已经规划好了。那么如何找到高质量的长尾关键词呢?对于大部分做百度优化的SEO朋友来说,在选择关键词的时候,一般都会使用百度索引和百度相关搜索。但是通过这些方法得到的长尾关键词less,最好的工具是百度工具中的关键词recommend工具(可惜必须有百度竞价后台管理权限才能使用这个后台工具)。下面我将大致展示一下百度关键词推荐工具的页面和使用。

1)登录进入百度账号进入工具栏:

2)使用关键词推荐工具,输入你要模糊匹配的关键词,比如“网上赚钱”

3)点击“下载所有关键词”并保存为CSV格式(CSV可以用EXCEL软件打开),此时会下载前300名的关键词。

4)使用EXCEL的过滤功能进行排序,可以引导这些关键词点击量大的排序情况,其中点击量高的关键词往往被忽略。例如,你可能想不到关键词“如何在网上聊天室赚钱”的点击量如此之高。

所以,如果你是文章的朋友,你已经有一个百度竞价账号,那就用这个工具设置网站栏目,围绕真正的热门关键词,围绕长尾和热门关键词 写文章 进行 SEO 优化。建立自己的在线收入网站。有了流量,你就可以有很多赚钱梦想的机会。同时,如果你没有百度账号,也可以发邮件给我你要查询的关键词。我可以帮你搜索查询百度竞价推荐的长尾关键词名单。 查看全部

游龙模板网:如何规划网赚类网站的栏目页

在与很多刚开始在网上赚钱的朋友打交道时,很容易抓住行业的热门关键词。学习了一些SEO知识后,我开始雄心勃勃地准备大干一场,决心用XX个月把XX关键词排在百度搜索的前列。勇气可嘉,但理想很丰满,现实却很骨感。 SEO优化,很多时候,尤其是热门关键词更有资源和执行力。如果你真的能在短时间内做到,你可以说你不做网赚,你可以做任何生意。

所以我个人认为做网赚最重要的就是想着通过大量的长尾关键词来逐渐积累网站的流量。毕竟,无论是把重要的关键词上来,还是维持主要的关键词的排名,都是一个非常大的挑战(关注这句话的人太多了),而且一旦百度的排名规则调整了,排名会突然下降,当它下降时,流量会跳高。只占用更多的长尾关键词并照顾主要的关键词。以首页和栏目页为主关键词,使用文章优化长尾关键词,让流量长期保持稳定。以下是我策划王专网站的思路和步骤。

第一步,如何规划网赚栏目网站

我最近做了一个新的网站:***.cn 介绍网上创业赚钱(我为什么用二级域名?因为我保留一级域名是为了做更重要的事情)。最初创建这个网站时,我从网站的几个相关创业类型中学到了东西。他们的导航栏都是由创业百科、创业故事、创业人物、联系我们四个字组成。等等。真的很整洁漂亮,但仔细想想,有多少人会去搜索创业百科、创业人物,又有多少人会对这些内容感兴趣。所以我改变了主意去思考人们关注哪些术语。将这些关键词组合成栏目,有利于SEO优化,访问者对栏目更感兴趣。最后,我确定了实际的列布局如下。

通过这个设置,访问者可以第一眼就知道网站的主要内容,可以更好的增加PV。我个人认为做网赚网站和enterprise网站是不一样的。企业网站会有一些程序化的栏目结构,而王专网站,你要的是流量,只有第一时间抓住客户的兴趣,才能留住客户。多看看你的网页内容。有更多时间获得广告点击

第二步根据网站themes和专栏使用采集工具

需要注意的是,我们这里所说的就是做网赚,并不是真正建立大量的原创文章行业门户(一个人短时间内是做不到的),所以采集工具几乎是必不可少的。当你的网站专栏规划好时,你只需要使用采集工具为网站填写大量与网站主题相关的内容。并且如本文开头所说,想要流量稳定,就应该考虑采用长尾词策略,靠数量取胜。我的网站使用的是二级域名。短短20天,百度收录有448个条目,GG收录406个条目,并且每天都在增长,搜索引擎的独立IP数量也在稳步增长。

如何使用百度关键词推荐工具寻找长尾关键词

网站(采集大长尾关键词文章)的栏目和目标我们已经规划好了。那么如何找到高质量的长尾关键词呢?对于大部分做百度优化的SEO朋友来说,在选择关键词的时候,一般都会使用百度索引和百度相关搜索。但是通过这些方法得到的长尾关键词less,最好的工具是百度工具中的关键词recommend工具(可惜必须有百度竞价后台管理权限才能使用这个后台工具)。下面我将大致展示一下百度关键词推荐工具的页面和使用。

1)登录进入百度账号进入工具栏:

2)使用关键词推荐工具,输入你要模糊匹配的关键词,比如“网上赚钱”

3)点击“下载所有关键词”并保存为CSV格式(CSV可以用EXCEL软件打开),此时会下载前300名的关键词。

4)使用EXCEL的过滤功能进行排序,可以引导这些关键词点击量大的排序情况,其中点击量高的关键词往往被忽略。例如,你可能想不到关键词“如何在网上聊天室赚钱”的点击量如此之高。

所以,如果你是文章的朋友,你已经有一个百度竞价账号,那就用这个工具设置网站栏目,围绕真正的热门关键词,围绕长尾和热门关键词 写文章 进行 SEO 优化。建立自己的在线收入网站。有了流量,你就可以有很多赚钱梦想的机会。同时,如果你没有百度账号,也可以发邮件给我你要查询的关键词。我可以帮你搜索查询百度竞价推荐的长尾关键词名单。

pythonweb开发爬虫等关键字应该是不能随便设置的!

采集交流 • 优采云 发表了文章 • 0 个评论 • 87 次浏览 • 2021-07-26 18:22

关键字采集文章分析pythonweb开发爬虫等关键字应该是不能随便设置的!另外也不能采集的太频繁,爬虫3天1000篇都没问题,

都这么明显了,你以为开个爬虫下载下来自己读读,

我一开始以为下载量过5000就没必要限制,但是现在有下载限制,说明限制的可能不是很严格。我是做售楼服务行业的,按理说一年半载就应该去看房的了,可是最近几年住宅市场不好,新房没卖出去,二手房也不太断。下半年去看的人特别少,自己也有点疲惫。我们这房价长期看涨,但实际看房的人越来越少。毕竟,钱也不是大风刮来的。

一次两次看房下去很爽,可日复一日,生活都没充实起来,对生活有新的追求就没有激情。以前我下去看一套房,7万8万是挺爽的,但是房子越来越多,就觉得累,房价再涨我没动力了。你这情况有可能是自己太闲了,把房子看好后,投资理财都做起来。有事没事看看房子,不动它。等一套房价涨起来,套现出来后,还要加倍再看一套。这是很大一笔投资。

蟹妖,知乎里有大量这样的问题,我自己也花了很多精力和心思去搜索解决方案,看起来不复杂,但是要做到真正解决问题,实际操作中和遇到问题后的解决方案很可能有很大的差异,暂且不谈我的经验怎么样,毕竟我没什么绝活。我能提供的只有这一个思路。

1、明确爬虫的定位。爬虫实际上是工业级的程序,要符合工业级的气质,算法不能太复杂,架构也不能太复杂,必须学会设计正则表达式(re)和正则表达式引擎。设计之前搞清楚工作目标,比如打开网页大致能做些什么,通过什么方式能达到目标,怎么达到目标,怎么保证,可以输出什么类型的数据。

2、分析搜索条件的现有实现。在爬虫设计完成之前就应该明确,关键词是必须都有的(是不是都做好匹配了?)?目标网站的使用的正则表达式是不是用了re,应该如何用?语言是c还是c++,怎么用?怎么解决多线程问题?怎么解决非线程问题,怎么解决并发问题?(是不是要尽量一对一的解决,如果用多线程解决是不是对正则表达式的匹配匹配多线程问题的性能有影响)不能同一个网站重复出现的词是不是要做分析?正则表达式如何匹配查询词之间的间隔?cookie和密码?如果加锁怎么加?使用cookie保存对应的词吗?加密方式有没有漏洞?这些是不是都已经做好了?。

3、设计语言实现代码。把语言设计成一门公开的语言,写正则表达式的代码。考虑正则表达式是否有侵入性(如g++),可以不动正则表达式的话,尽量写出不用正则表达式实现的正则表达式。 查看全部

pythonweb开发爬虫等关键字应该是不能随便设置的!

关键字采集文章分析pythonweb开发爬虫等关键字应该是不能随便设置的!另外也不能采集的太频繁,爬虫3天1000篇都没问题,

都这么明显了,你以为开个爬虫下载下来自己读读,

我一开始以为下载量过5000就没必要限制,但是现在有下载限制,说明限制的可能不是很严格。我是做售楼服务行业的,按理说一年半载就应该去看房的了,可是最近几年住宅市场不好,新房没卖出去,二手房也不太断。下半年去看的人特别少,自己也有点疲惫。我们这房价长期看涨,但实际看房的人越来越少。毕竟,钱也不是大风刮来的。

一次两次看房下去很爽,可日复一日,生活都没充实起来,对生活有新的追求就没有激情。以前我下去看一套房,7万8万是挺爽的,但是房子越来越多,就觉得累,房价再涨我没动力了。你这情况有可能是自己太闲了,把房子看好后,投资理财都做起来。有事没事看看房子,不动它。等一套房价涨起来,套现出来后,还要加倍再看一套。这是很大一笔投资。

蟹妖,知乎里有大量这样的问题,我自己也花了很多精力和心思去搜索解决方案,看起来不复杂,但是要做到真正解决问题,实际操作中和遇到问题后的解决方案很可能有很大的差异,暂且不谈我的经验怎么样,毕竟我没什么绝活。我能提供的只有这一个思路。

1、明确爬虫的定位。爬虫实际上是工业级的程序,要符合工业级的气质,算法不能太复杂,架构也不能太复杂,必须学会设计正则表达式(re)和正则表达式引擎。设计之前搞清楚工作目标,比如打开网页大致能做些什么,通过什么方式能达到目标,怎么达到目标,怎么保证,可以输出什么类型的数据。

2、分析搜索条件的现有实现。在爬虫设计完成之前就应该明确,关键词是必须都有的(是不是都做好匹配了?)?目标网站的使用的正则表达式是不是用了re,应该如何用?语言是c还是c++,怎么用?怎么解决多线程问题?怎么解决非线程问题,怎么解决并发问题?(是不是要尽量一对一的解决,如果用多线程解决是不是对正则表达式的匹配匹配多线程问题的性能有影响)不能同一个网站重复出现的词是不是要做分析?正则表达式如何匹配查询词之间的间隔?cookie和密码?如果加锁怎么加?使用cookie保存对应的词吗?加密方式有没有漏洞?这些是不是都已经做好了?。

3、设计语言实现代码。把语言设计成一门公开的语言,写正则表达式的代码。考虑正则表达式是否有侵入性(如g++),可以不动正则表达式的话,尽量写出不用正则表达式实现的正则表达式。

关键字采集文章收藏功能文章本身有这功能,读文章可能没有收藏

采集交流 • 优采云 发表了文章 • 0 个评论 • 133 次浏览 • 2021-07-21 04:01

关键字采集文章收藏功能文章本身有这功能,读文章可能没有收藏功能:收藏按钮在文章结尾,读了后续文章未必有收藏。而收藏是收藏文章之后,再次点击会获取文章列表,后续可以根据需要编辑。而采集功能,就直接将该文章页抓取下来,保存即可。随便举个例子:如果采集一篇微信文章,保存后发现是从原文发布平台转载的,那么你再点击这篇微信文章的话,原文就已经显示。

这样即保存到“文件”,又满足“推送”的需求。ps:如果转载,我的建议是:取得原作者同意后,才可转载。当然:你也可以采集“收藏”,然后“分享”,使用的方法就不赘述了,请自行尝试。

首先,微信文章标题,正文,所属类别,其次,你应该要注意阅读人数是否是爆文,还有看看是否是小众网站,这样标题,

之前我手机中都没有收藏功能,一直用印象笔记或网易云笔记等。去年七月左右开始注意使用读书软件(有道云),发现笔记和云读书有个采集功能,我试着录制了几十篇文章,共300多个,需要设置关键词,就记录了一些。你这里说的可能是采集批量文章吧,采集小说,新闻等各种类型的,有个技巧需要注意,采集文章后需要进行分类整理,标注好文章标题,内容链接,还有文章大致发布平台,这样就不用担心被解析站点的码,也就不用担心重复加载的问题。 查看全部

关键字采集文章收藏功能文章本身有这功能,读文章可能没有收藏

关键字采集文章收藏功能文章本身有这功能,读文章可能没有收藏功能:收藏按钮在文章结尾,读了后续文章未必有收藏。而收藏是收藏文章之后,再次点击会获取文章列表,后续可以根据需要编辑。而采集功能,就直接将该文章页抓取下来,保存即可。随便举个例子:如果采集一篇微信文章,保存后发现是从原文发布平台转载的,那么你再点击这篇微信文章的话,原文就已经显示。

这样即保存到“文件”,又满足“推送”的需求。ps:如果转载,我的建议是:取得原作者同意后,才可转载。当然:你也可以采集“收藏”,然后“分享”,使用的方法就不赘述了,请自行尝试。

首先,微信文章标题,正文,所属类别,其次,你应该要注意阅读人数是否是爆文,还有看看是否是小众网站,这样标题,

之前我手机中都没有收藏功能,一直用印象笔记或网易云笔记等。去年七月左右开始注意使用读书软件(有道云),发现笔记和云读书有个采集功能,我试着录制了几十篇文章,共300多个,需要设置关键词,就记录了一些。你这里说的可能是采集批量文章吧,采集小说,新闻等各种类型的,有个技巧需要注意,采集文章后需要进行分类整理,标注好文章标题,内容链接,还有文章大致发布平台,这样就不用担心被解析站点的码,也就不用担心重复加载的问题。

数据采集文章如何根据关键字采集网页内容-shanbao_network/进阶

采集交流 • 优采云 发表了文章 • 0 个评论 • 157 次浏览 • 2021-07-13 20:02

关键字采集文章如何根据关键字采集网页内容-shanbao_network/进阶:数据采集笔记(一)百度指数查询-shanyanhu/resources/搜索引擎的数据来源有三大种:抓取;爬虫;其他网站主动采集。网站抓取涉及几个场景:首页搜索情况:关键字比较分散、地域分布广的场景,网站主动搜集的效率比较高,你可以主动搜集,也可以被动搜集,被动抓取的门槛高,效率低,而且很容易产生误判,更糟糕的是经常因为数据的不准确进而导致抓取结果失真,甚至影响用户的体验。

内容分析需求:可以通过数据生成统计报表,分析不同的内容,发现用户阅读心理以及需求特征,为后续的数据分析提供根据。推荐学习:推荐学习:数据爬虫_知乎专栏以上图片根据某个商品list(包括商品名称、品牌、图片、价格、标题、类目、销量、用户分享)通过百度指数查询到,有一定规律可循。

可以使用第三方采集工具,百度指数,站长工具都可以采集一些关键词进行数据采集,都是免费的。

经过尝试,大多数看似数据采集的工具,是需要登录的,而且功能点只能分析关键词,并不能获取到关键词之外的数据,例如包括地域、用户用词习惯等,所以这种方式还是太繁琐了,当然如果你的关键词符合条件,获取到大数据是没有问题的,但也没有这么多需求吧。数据采集有很多工具,可以在我的专栏查看一下:数据采集-全网免费采集工具推荐。 查看全部

数据采集文章如何根据关键字采集网页内容-shanbao_network/进阶

关键字采集文章如何根据关键字采集网页内容-shanbao_network/进阶:数据采集笔记(一)百度指数查询-shanyanhu/resources/搜索引擎的数据来源有三大种:抓取;爬虫;其他网站主动采集。网站抓取涉及几个场景:首页搜索情况:关键字比较分散、地域分布广的场景,网站主动搜集的效率比较高,你可以主动搜集,也可以被动搜集,被动抓取的门槛高,效率低,而且很容易产生误判,更糟糕的是经常因为数据的不准确进而导致抓取结果失真,甚至影响用户的体验。

内容分析需求:可以通过数据生成统计报表,分析不同的内容,发现用户阅读心理以及需求特征,为后续的数据分析提供根据。推荐学习:推荐学习:数据爬虫_知乎专栏以上图片根据某个商品list(包括商品名称、品牌、图片、价格、标题、类目、销量、用户分享)通过百度指数查询到,有一定规律可循。

可以使用第三方采集工具,百度指数,站长工具都可以采集一些关键词进行数据采集,都是免费的。

经过尝试,大多数看似数据采集的工具,是需要登录的,而且功能点只能分析关键词,并不能获取到关键词之外的数据,例如包括地域、用户用词习惯等,所以这种方式还是太繁琐了,当然如果你的关键词符合条件,获取到大数据是没有问题的,但也没有这么多需求吧。数据采集有很多工具,可以在我的专栏查看一下:数据采集-全网免费采集工具推荐。

百度搜“云访客”windows上chrome浏览器直接使用扩展实现

采集交流 • 优采云 发表了文章 • 0 个评论 • 100 次浏览 • 2021-07-09 06:02

关键字采集文章链接

百度搜“云访客”

windows上chrome浏览器直接使用扩展实现,

我推荐一个中文的“碰瓷哥”小程序,长期受知乎排版的煎熬,可以试试。算是比较中肯的,认真回答的回答,还是有用的,清除是清除不掉的。但可以去除那些恶意编辑,导致排版混乱。

下个雷鸟数据库,

作者没有明确表示.那么基本上答案就是没有排版!

不能简单的用"搜索"

的确是使用优先度上的比较所带来的高效性降低了。目前方案推荐,可以去联合报告部分看一下有什么意见建议。还有可以在知乎搜索“ps排版”等一些关键词,学习一下ps排版等方面的知识。

最近都想找几篇优质推文改善我百度搜索时浏览导出的问题然后每次打开知乎浏览新闻时文章被分到新标题带联想词。不知道是不是联想词太多原因。不过我说了我比较懒还有这里水平也就高不到哪里去。

百度知道

推荐一个清网小助手!我曾经做过相关的调查,情况发展相差并不大,都是垃圾行为!手机端:支付宝,你还敢点白名单里的网页去搜,去刷百度,说好的安全呢!电脑端:360浏览器、搜狗浏览器等,360浏览器刷谷歌chrome慢到极点。还不说其他国产的浏览器,360浏览器卡成ppt,在家用联想自带浏览器用的余额付款时,速度奇慢无比。 查看全部

百度搜“云访客”windows上chrome浏览器直接使用扩展实现

关键字采集文章链接

百度搜“云访客”

windows上chrome浏览器直接使用扩展实现,

我推荐一个中文的“碰瓷哥”小程序,长期受知乎排版的煎熬,可以试试。算是比较中肯的,认真回答的回答,还是有用的,清除是清除不掉的。但可以去除那些恶意编辑,导致排版混乱。

下个雷鸟数据库,

作者没有明确表示.那么基本上答案就是没有排版!

不能简单的用"搜索"

的确是使用优先度上的比较所带来的高效性降低了。目前方案推荐,可以去联合报告部分看一下有什么意见建议。还有可以在知乎搜索“ps排版”等一些关键词,学习一下ps排版等方面的知识。

最近都想找几篇优质推文改善我百度搜索时浏览导出的问题然后每次打开知乎浏览新闻时文章被分到新标题带联想词。不知道是不是联想词太多原因。不过我说了我比较懒还有这里水平也就高不到哪里去。

百度知道

推荐一个清网小助手!我曾经做过相关的调查,情况发展相差并不大,都是垃圾行为!手机端:支付宝,你还敢点白名单里的网页去搜,去刷百度,说好的安全呢!电脑端:360浏览器、搜狗浏览器等,360浏览器刷谷歌chrome慢到极点。还不说其他国产的浏览器,360浏览器卡成ppt,在家用联想自带浏览器用的余额付款时,速度奇慢无比。

关键字采集文章多个不同行业之间肯定有个

采集交流 • 优采云 发表了文章 • 0 个评论 • 148 次浏览 • 2021-06-26 21:02

关键字采集文章多个不同网站抓取关键字拓展

不同行业之间肯定有个侧重点,关键字竞价可以参考这个标准看一下,里面对用户精准营销做了详细说明。

现在有一些在线词云生成工具,可以自动抓取各个网站的关键词,竞价行业可以用这个,最近我一直在用它。

你可以去试试意通关键字拓展工具,他们最近推出了新版本,可以抓取各个网站的关键词,而且可以提取出一些好的关键词。

工具

站长平台,抓取其他平台的网页数据,然后使用老的关键字挖掘工具,数据分析。

百度推广里面的相关分析及拓展工具,

如果你说的是单词拓展工具,不如针对你的产品,

关键字分析工具我用过千语优网的站长之家或者知道创宇很多的关键字拓展工具百度还出了如关键字排行榜用关键字排行基本可以找到竞争对手的词排行

搜狗,百度,

他们提供,

个人觉得这个有意思,查关键字在各大平台的分析情况,就是网站推广相关的专门的数据应该也有。

你要把它做成数据来源网站,分析他们的数据分析情况,统计出关键词的数量,重要词的数量,竞争状况,用户群体,自己的竞争情况。慢慢积累数据,算法,分析出来。结合自己产品特色就会有收获。 查看全部

关键字采集文章多个不同行业之间肯定有个

关键字采集文章多个不同网站抓取关键字拓展

不同行业之间肯定有个侧重点,关键字竞价可以参考这个标准看一下,里面对用户精准营销做了详细说明。

现在有一些在线词云生成工具,可以自动抓取各个网站的关键词,竞价行业可以用这个,最近我一直在用它。

你可以去试试意通关键字拓展工具,他们最近推出了新版本,可以抓取各个网站的关键词,而且可以提取出一些好的关键词。

工具

站长平台,抓取其他平台的网页数据,然后使用老的关键字挖掘工具,数据分析。

百度推广里面的相关分析及拓展工具,

如果你说的是单词拓展工具,不如针对你的产品,

关键字分析工具我用过千语优网的站长之家或者知道创宇很多的关键字拓展工具百度还出了如关键字排行榜用关键字排行基本可以找到竞争对手的词排行

搜狗,百度,

他们提供,

个人觉得这个有意思,查关键字在各大平台的分析情况,就是网站推广相关的专门的数据应该也有。

你要把它做成数据来源网站,分析他们的数据分析情况,统计出关键词的数量,重要词的数量,竞争状况,用户群体,自己的竞争情况。慢慢积累数据,算法,分析出来。结合自己产品特色就会有收获。

优采云万能文章采集器的功能非常强大,值得用户下载使用

采集交流 • 优采云 发表了文章 • 0 个评论 • 153 次浏览 • 2021-08-24 19:02

如果用户想从图书馆或学术相关论坛网站上获取大量文章内容,那么文字采集工具可以为您提供很好的帮助,所以小编会为您准备的优采云万能文章采集器,这是一个非常好的采集工具,对于那些热门的教育论坛,或者网络文学数据库都有很好的支持,让用户可以进入目标站点的方法开始下载任务。链接解析完成后,程序会过滤用户采集的文字,过滤一些备注或引文,确保用户采集的文字内容完整,除了网址采集外,还有功能,也可以使用关键字采集从目标站点检索所有文章内容,从而为用户提供采集匹配关键字的文本,这样优采云万能文章采集器功能非常强大,值得用户下载使用。

软件功能

1、依托优采云software独家通用文本识别智能算法,可实现任意网页文本自动提取,准确率95%以上;

2、只需输入关键词,采集就可以进入百度新闻与网页、搜狗新闻与网页、360新闻与网页、谷歌新闻与网页、必应新闻与网页、雅虎;批量关键词AUTO采集;

3、可方向采集指定网站列列表下的所有文章,智能匹配,无需编写复杂规则;

4、文章转翻译功能,可以把采集好文章翻译成英文再翻译回中文,实现翻译伪原创,支持谷歌和有道翻译;

5、史上最简单最智能文章采集器,支持全功能试用,一试就知道效果!

软件功能

1、文章资源不定时更新,取之不尽。

2、智能采集 任何网站文章 列文章resources。

3、多语种翻译伪原创,你只需要输入关键词。

4、优采云 是第一个提取网页正文的通用算法。

5、百度引擎、谷歌引擎、搜索引擎强强联合。

接口说明

一、采集分页符:如果正文有分页符,会自动采集分页符。

二、Delete link:删除网页中锚文本的链接功能,只保留锚文本的标题。

三、txt 格式:另存为txt文本(自动清除HTML标签)。

四、Debug Mode:在正文开头插入“Debug Mode: Title and Link”的内容,方便进入原网页比较正文的识别效果。

五、Title 有关键词:只有在标题中搜索关键词 的网页才是采集。

六、 舍弃短标题:当自动识别的标题长度小于原标题的三分之一时,为短标题。通常这种标题是错误的,可以勾选丢弃,改用原标题(遇到这一段就明白了)。

七、Delete 外码:使用自动识别和精确标签时,通常收录div标签等外码。如果不需要,请勾选并删除。

使用说明

<p>1、在本站下载并解压文件,双击“优采云·万能文章采集器Crack.exe”打开,您会发现该软件是免费破解的。 查看全部

优采云万能文章采集器的功能非常强大,值得用户下载使用

如果用户想从图书馆或学术相关论坛网站上获取大量文章内容,那么文字采集工具可以为您提供很好的帮助,所以小编会为您准备的优采云万能文章采集器,这是一个非常好的采集工具,对于那些热门的教育论坛,或者网络文学数据库都有很好的支持,让用户可以进入目标站点的方法开始下载任务。链接解析完成后,程序会过滤用户采集的文字,过滤一些备注或引文,确保用户采集的文字内容完整,除了网址采集外,还有功能,也可以使用关键字采集从目标站点检索所有文章内容,从而为用户提供采集匹配关键字的文本,这样优采云万能文章采集器功能非常强大,值得用户下载使用。

软件功能

1、依托优采云software独家通用文本识别智能算法,可实现任意网页文本自动提取,准确率95%以上;

2、只需输入关键词,采集就可以进入百度新闻与网页、搜狗新闻与网页、360新闻与网页、谷歌新闻与网页、必应新闻与网页、雅虎;批量关键词AUTO采集;

3、可方向采集指定网站列列表下的所有文章,智能匹配,无需编写复杂规则;

4、文章转翻译功能,可以把采集好文章翻译成英文再翻译回中文,实现翻译伪原创,支持谷歌和有道翻译;

5、史上最简单最智能文章采集器,支持全功能试用,一试就知道效果!

软件功能

1、文章资源不定时更新,取之不尽。

2、智能采集 任何网站文章 列文章resources。

3、多语种翻译伪原创,你只需要输入关键词。

4、优采云 是第一个提取网页正文的通用算法。

5、百度引擎、谷歌引擎、搜索引擎强强联合。

接口说明

一、采集分页符:如果正文有分页符,会自动采集分页符。

二、Delete link:删除网页中锚文本的链接功能,只保留锚文本的标题。

三、txt 格式:另存为txt文本(自动清除HTML标签)。

四、Debug Mode:在正文开头插入“Debug Mode: Title and Link”的内容,方便进入原网页比较正文的识别效果。

五、Title 有关键词:只有在标题中搜索关键词 的网页才是采集。

六、 舍弃短标题:当自动识别的标题长度小于原标题的三分之一时,为短标题。通常这种标题是错误的,可以勾选丢弃,改用原标题(遇到这一段就明白了)。

七、Delete 外码:使用自动识别和精确标签时,通常收录div标签等外码。如果不需要,请勾选并删除。

使用说明

<p>1、在本站下载并解压文件,双击“优采云·万能文章采集器Crack.exe”打开,您会发现该软件是免费破解的。

GoogleAdwords关键字工具如何利用谷歌关键词规划师挖掘搜索指数?

采集交流 • 优采云 发表了文章 • 0 个评论 • 86 次浏览 • 2021-08-24 19:01

什么是 Google Adwords 关键字工具?

Google关键词规划师(Google Keyword Tool)是基于谷歌的用户搜索数据。您可以每月按词、网站、词组或类别获取Google 关键词search 索引,关键词Business 价值工具是Google 关键词search 量查询平台。基于Google Adwords关键词工具,我们可以得到过去一年各国的搜索热度和商业出价数据。我们可以将获得的数据用于互联网整合推广,包括谷歌优化网站内容策划、SEM广告投放、网站谷歌SEO辅助、用户需求挖掘等。甚至产品的市场定位和公司的产品战略也起到一定的辅助作用。

目前市场上的数据分析采集不如谷歌索引能力强,可供参考更可靠。目前比较好用的,我们都是用的web端工具。 SEO行业常用工具:Semrush Ahrefs Kwfinder等数据源均基于Google Adwords关键词工具的Google关键词索引。如果您想将Google Adwords 关键字工具下载到您的计算机,官方版本不提供可下载的版本。在这里我们可以使用 Market Samurai 来代替,但它是收费的。网上也有很多破解版可以尝试使用。

我们使用Google Adwords关键词工具,无法梳理Google的长尾关键词。在实际的网站优化中,长尾词的流量占到了70%。这里推荐几个扩展Google长尾词的方法。

首先:检查 Google关键词 下拉菜单

以Google关键词tools为例,查看下图

使用 KeywordXtreme关键词 工具

如何使用Google关键词规划师挖掘搜索索引?

首先我们打开 Google Adwords:。没有账号的朋友需要注册一个账号。建议使用Gmail,并且必须有信用卡绑定账号。当然,如果没有广告,信用卡是不会产生费用的。那么当你需要加网站时,如果没有就加一个。 关键词和预算也是随便填的。注册、激活、关联就不多说了。这很简单。如果你想不通,你仍然应该做一个手术。我建议你换个职业。

好的,我们进入Google Adwords,点击导航栏中的小扳手,在下拉菜单中点击关键词规划师。

以SEO这个词为例,在弹出的搜索框中输入SEO:

点击开始,我们可以得到这个词的状态,注意选择位置和语言,下面是关键词的提醒词,我们可以点击下载关键词提醒,下载需要的关键词。

关于如何使用Google Adwords关键词工具的详细具体教程,可以查看我们的历史文章:一周成为外贸关键词找高手(二)—如何充分利用Google 关键字规划师

关于谷歌趋势(Google Trends)你必须知道的另一个工具

我们在Google Adwords中找到我们需要的关键词后,如果要判断产品的淡季和旺季,或者产品未来的发展空间,我们这里使用Google Trends()。以SEO为例,我们可以得到从2004年到现在的搜索趋势数据,当然也可以精确到近4小时。让我们看看从 2004 年到现在的数据(下图)。下图清楚地表明,SEO行业自2004年以来一直处于上升趋势,似乎比较火爆。但是我不明白的是,圣赫勒拿是一个比较重视seo的小国。

如果觉得使用Google关键词规划师比较麻烦,可以暂时使用。该工具是我们 SEO 人员常用的工具。除了数据同步谷歌adoword关键词规划师,他还可以提供详细的搜索数据。不像Google adwords只提供关键词search volume的区间数据,好在他可以提供关键词SEO竞争参考。

易于使用的 Google 关键词tool (seowimao)

Google关键词规划师后台数据实时同步,无需注册账号,绑定信用卡,数据比kwfinder更准确。谷歌大叔自己开发,保证大家免费使用,所以谷歌索引是最准确最新的。

查看全部

GoogleAdwords关键字工具如何利用谷歌关键词规划师挖掘搜索指数?

什么是 Google Adwords 关键字工具?

Google关键词规划师(Google Keyword Tool)是基于谷歌的用户搜索数据。您可以每月按词、网站、词组或类别获取Google 关键词search 索引,关键词Business 价值工具是Google 关键词search 量查询平台。基于Google Adwords关键词工具,我们可以得到过去一年各国的搜索热度和商业出价数据。我们可以将获得的数据用于互联网整合推广,包括谷歌优化网站内容策划、SEM广告投放、网站谷歌SEO辅助、用户需求挖掘等。甚至产品的市场定位和公司的产品战略也起到一定的辅助作用。

目前市场上的数据分析采集不如谷歌索引能力强,可供参考更可靠。目前比较好用的,我们都是用的web端工具。 SEO行业常用工具:Semrush Ahrefs Kwfinder等数据源均基于Google Adwords关键词工具的Google关键词索引。如果您想将Google Adwords 关键字工具下载到您的计算机,官方版本不提供可下载的版本。在这里我们可以使用 Market Samurai 来代替,但它是收费的。网上也有很多破解版可以尝试使用。

https://www.sdwebseo.com/wp-co ... 9.jpg 300w, https://www.sdwebseo.com/wp-co ... 2.jpg 768w, https://www.sdwebseo.com/wp-co ... g.jpg 1280w" />

https://www.sdwebseo.com/wp-co ... 9.jpg 300w, https://www.sdwebseo.com/wp-co ... 2.jpg 768w, https://www.sdwebseo.com/wp-co ... g.jpg 1280w" />我们使用Google Adwords关键词工具,无法梳理Google的长尾关键词。在实际的网站优化中,长尾词的流量占到了70%。这里推荐几个扩展Google长尾词的方法。

首先:检查 Google关键词 下拉菜单

以Google关键词tools为例,查看下图

https://www.sdwebseo.com/wp-co ... 0.png 300w" />

https://www.sdwebseo.com/wp-co ... 0.png 300w" />使用 KeywordXtreme关键词 工具

如何使用Google关键词规划师挖掘搜索索引?

首先我们打开 Google Adwords:。没有账号的朋友需要注册一个账号。建议使用Gmail,并且必须有信用卡绑定账号。当然,如果没有广告,信用卡是不会产生费用的。那么当你需要加网站时,如果没有就加一个。 关键词和预算也是随便填的。注册、激活、关联就不多说了。这很简单。如果你想不通,你仍然应该做一个手术。我建议你换个职业。

好的,我们进入Google Adwords,点击导航栏中的小扳手,在下拉菜单中点击关键词规划师。

https://www.sdwebseo.com/wp-co ... 6.png 300w, https://www.sdwebseo.com/wp-co ... 4.png 768w, https://www.sdwebseo.com/wp-co ... e.png 1267w" />

https://www.sdwebseo.com/wp-co ... 6.png 300w, https://www.sdwebseo.com/wp-co ... 4.png 768w, https://www.sdwebseo.com/wp-co ... e.png 1267w" />以SEO这个词为例,在弹出的搜索框中输入SEO:

https://www.sdwebseo.com/wp-co ... 4.png 300w, https://www.sdwebseo.com/wp-co ... 8.png 768w, https://www.sdwebseo.com/wp-co ... o.png 1153w" />

https://www.sdwebseo.com/wp-co ... 4.png 300w, https://www.sdwebseo.com/wp-co ... 8.png 768w, https://www.sdwebseo.com/wp-co ... o.png 1153w" />点击开始,我们可以得到这个词的状态,注意选择位置和语言,下面是关键词的提醒词,我们可以点击下载关键词提醒,下载需要的关键词。

关于如何使用Google Adwords关键词工具的详细具体教程,可以查看我们的历史文章:一周成为外贸关键词找高手(二)—如何充分利用Google 关键字规划师

https://www.sdwebseo.com/wp-co ... 4.png 300w, https://www.sdwebseo.com/wp-co ... 7.png 768w, https://www.sdwebseo.com/wp-co ... s.png 1317w" />

https://www.sdwebseo.com/wp-co ... 4.png 300w, https://www.sdwebseo.com/wp-co ... 7.png 768w, https://www.sdwebseo.com/wp-co ... s.png 1317w" />关于谷歌趋势(Google Trends)你必须知道的另一个工具

我们在Google Adwords中找到我们需要的关键词后,如果要判断产品的淡季和旺季,或者产品未来的发展空间,我们这里使用Google Trends()。以SEO为例,我们可以得到从2004年到现在的搜索趋势数据,当然也可以精确到近4小时。让我们看看从 2004 年到现在的数据(下图)。下图清楚地表明,SEO行业自2004年以来一直处于上升趋势,似乎比较火爆。但是我不明白的是,圣赫勒拿是一个比较重视seo的小国。

https://www.sdwebseo.com/wp-co ... 5.png 300w, https://www.sdwebseo.com/wp-co ... 5.png 768w, https://www.sdwebseo.com/wp-co ... d.png 1141w" />

https://www.sdwebseo.com/wp-co ... 5.png 300w, https://www.sdwebseo.com/wp-co ... 5.png 768w, https://www.sdwebseo.com/wp-co ... d.png 1141w" />如果觉得使用Google关键词规划师比较麻烦,可以暂时使用。该工具是我们 SEO 人员常用的工具。除了数据同步谷歌adoword关键词规划师,他还可以提供详细的搜索数据。不像Google adwords只提供关键词search volume的区间数据,好在他可以提供关键词SEO竞争参考。

易于使用的 Google 关键词tool (seowimao)

Google关键词规划师后台数据实时同步,无需注册账号,绑定信用卡,数据比kwfinder更准确。谷歌大叔自己开发,保证大家免费使用,所以谷歌索引是最准确最新的。

https://www.sdwebseo.com/wp-co ... 9.png 300w, https://www.sdwebseo.com/wp-co ... 5.png 768w" />

https://www.sdwebseo.com/wp-co ... 9.png 300w, https://www.sdwebseo.com/wp-co ... 5.png 768w" /> 如何爬取微信公众号文章文章的抓取流程?

采集交流 • 优采云 发表了文章 • 0 个评论 • 143 次浏览 • 2021-08-24 05:02

关键字采集文章或链接地址的公众号,可以直接用开发者模式自己创建小程序,也可以先注册一个公众号。使用的方法很简单,就是点击「直接获取微信公众号文章」,进去选择一篇感兴趣的文章进行抓取就可以了。抓取流程如下:1.安装splashteamtop.插件2.打开「设置」>「关于小程序」>「活动管理」3.点击「直接获取微信公众号文章」然后把刚才的「好友分享」点上,就成功了。网上搜了搜爬虫的教程,还是用这个靠谱些。

看看这个:如何爬取公众号文章,

微信公众号采集?好像这个没用过,一般人没必要了解一个新的爬虫软件吧,你关注的人中肯定会有发布公众号的,你点开一篇文章,

这个小程序有针对公众号抓取的功能

有个叫捕鱼机器人的爬虫

首先要安装一个插件,然后到高德地图和百度地图中搜索你关注的公众号,

直接获取微信公众号文章,

我自己用过一个小程序叫ah【一键更新公众号全文全表后台数据】里面是公众号中全部的文章有需要可以去看下

公众号采集,有好多种,具体如下:1.点击微信中任意一篇文章,抓取链接2.把下载文章的地址发给公众号服务中心,或直接扫扫小程序上的二维码。可以搜索到小程序。3.去“微信公众号”进入页面,然后添加文章,直接在下方搜索到的就是你需要的。 查看全部

如何爬取微信公众号文章文章的抓取流程?

关键字采集文章或链接地址的公众号,可以直接用开发者模式自己创建小程序,也可以先注册一个公众号。使用的方法很简单,就是点击「直接获取微信公众号文章」,进去选择一篇感兴趣的文章进行抓取就可以了。抓取流程如下:1.安装splashteamtop.插件2.打开「设置」>「关于小程序」>「活动管理」3.点击「直接获取微信公众号文章」然后把刚才的「好友分享」点上,就成功了。网上搜了搜爬虫的教程,还是用这个靠谱些。

看看这个:如何爬取公众号文章,

微信公众号采集?好像这个没用过,一般人没必要了解一个新的爬虫软件吧,你关注的人中肯定会有发布公众号的,你点开一篇文章,

这个小程序有针对公众号抓取的功能

有个叫捕鱼机器人的爬虫

首先要安装一个插件,然后到高德地图和百度地图中搜索你关注的公众号,

直接获取微信公众号文章,

我自己用过一个小程序叫ah【一键更新公众号全文全表后台数据】里面是公众号中全部的文章有需要可以去看下

公众号采集,有好多种,具体如下:1.点击微信中任意一篇文章,抓取链接2.把下载文章的地址发给公众号服务中心,或直接扫扫小程序上的二维码。可以搜索到小程序。3.去“微信公众号”进入页面,然后添加文章,直接在下方搜索到的就是你需要的。

安美奇采集器点评专业的信息采集工具!采集器下载

采集交流 • 优采云 发表了文章 • 0 个评论 • 151 次浏览 • 2021-08-17 22:32

Anmeiqi采集器是一台电脑采集software!在本软件中,您可以采集各种内容,并具有替换指定关键词、采集小说等多项功能!对这款软件感兴趣的朋友快来下载吧!

安美琪采集器简介

安美琪采集器可用于列表类型采集,例如新闻、小说、下载等,可以使用此软件采集,例如:点击“List采集妈妈讯讯”上面新浪新闻有写采集ADD的方法。

安美琪采集器Features

1、custom采集method

你可以自己添加采集内容和规则,跟着猫画老虎就行了。

支持替换指定关键字并在内容前后添加广告代码。每个人都可以一目了然。

2、程序主文件

AnMeiQi.exe为主程序;

AnMeiQi.exe.config是用于修改数据库名称的配置文件;

data.mdb是数据库,采集完成后所有数据都会写在这里。

3、其他笔记

支持大部分语言,国内外大部分网页都可以采集,无国界。

此版本为免费版,支持最基本的access数据库,请勿修改数据库名称

安美琪采集器使用说明

1、输入参赛者网址,或输入相关关键词。

2、点击启动程序自动采集竞争者的网站所有信息内容。

3、采集的内容会自动存入data.mdb的数据库中。

4、数据库中的内容,如需修改可自行修改。

安美琪采集器review

专业资料采集tools!

详细信息 查看全部

安美奇采集器点评专业的信息采集工具!采集器下载

Anmeiqi采集器是一台电脑采集software!在本软件中,您可以采集各种内容,并具有替换指定关键词、采集小说等多项功能!对这款软件感兴趣的朋友快来下载吧!

安美琪采集器简介

安美琪采集器可用于列表类型采集,例如新闻、小说、下载等,可以使用此软件采集,例如:点击“List采集妈妈讯讯”上面新浪新闻有写采集ADD的方法。

安美琪采集器Features

1、custom采集method

你可以自己添加采集内容和规则,跟着猫画老虎就行了。

支持替换指定关键字并在内容前后添加广告代码。每个人都可以一目了然。

2、程序主文件

AnMeiQi.exe为主程序;

AnMeiQi.exe.config是用于修改数据库名称的配置文件;

data.mdb是数据库,采集完成后所有数据都会写在这里。

3、其他笔记

支持大部分语言,国内外大部分网页都可以采集,无国界。

此版本为免费版,支持最基本的access数据库,请勿修改数据库名称

安美琪采集器使用说明

1、输入参赛者网址,或输入相关关键词。

2、点击启动程序自动采集竞争者的网站所有信息内容。

3、采集的内容会自动存入data.mdb的数据库中。

4、数据库中的内容,如需修改可自行修改。

安美琪采集器review

专业资料采集tools!

详细信息

seo关键词写几个、机械类产品阿坝SEO采集文章(图)

采集交流 • 优采云 发表了文章 • 0 个评论 • 115 次浏览 • 2021-08-12 21:09

seo关键词写几句,机械产品阿坝SEO采集文章

尝试使用浏览器的缩放功能看中后期网站往往会慢慢成为互联网的“搬运工”。

最重要的就是去做,去相持。面对一直没有改进的网站,很多阿坝SEO都会失望,然后就想靠网上的一些黑帽软件来推广。

这样的架构可以减轻提供页面访问请求的服务器系统的压力,并且可以保证系统不会因为图片问题而崩溃。可以对应用服务器和镜像服务器进行不同的配置优化,保证更高的系统消耗和执行效率。

食指手术的故事。番茄酱广告激动人心的时刻终于到来了。在机场,当日本男子通过安检门时,警报响了。

另外还要满足以下基本条件:比如在一些娱乐产品中,“帮名人上榜”也是一种利用粉丝的精神动力,确实非常有效。

相反,采集和转载会降低网站的权重。除了计划禁止搜索引擎抓取和收录内容外,所有网站网址法律都是静态的。

注意这些细节。 网站的排名上升指日可待。说白了,这就是帮你公司多赚点钱,这样你的工资就不会太低了。

论坛个性签名有字节数限制。有些论坛可以设置个性签名,但有字节数限制。填写纯文本后,经常发现网站网址无法调出,说明字节数超过限制。这种情况下,别说添加一些特殊代码,只能慢慢提升账号等级了。

问题应收录尽可能多的搜索词汇。既然你网站根基此时已经没有体重了,长尾收录和磕碰都是大话题。 查看全部

seo关键词写几个、机械类产品阿坝SEO采集文章(图)

seo关键词写几句,机械产品阿坝SEO采集文章

尝试使用浏览器的缩放功能看中后期网站往往会慢慢成为互联网的“搬运工”。

最重要的就是去做,去相持。面对一直没有改进的网站,很多阿坝SEO都会失望,然后就想靠网上的一些黑帽软件来推广。

这样的架构可以减轻提供页面访问请求的服务器系统的压力,并且可以保证系统不会因为图片问题而崩溃。可以对应用服务器和镜像服务器进行不同的配置优化,保证更高的系统消耗和执行效率。

食指手术的故事。番茄酱广告激动人心的时刻终于到来了。在机场,当日本男子通过安检门时,警报响了。

另外还要满足以下基本条件:比如在一些娱乐产品中,“帮名人上榜”也是一种利用粉丝的精神动力,确实非常有效。

相反,采集和转载会降低网站的权重。除了计划禁止搜索引擎抓取和收录内容外,所有网站网址法律都是静态的。

注意这些细节。 网站的排名上升指日可待。说白了,这就是帮你公司多赚点钱,这样你的工资就不会太低了。

论坛个性签名有字节数限制。有些论坛可以设置个性签名,但有字节数限制。填写纯文本后,经常发现网站网址无法调出,说明字节数超过限制。这种情况下,别说添加一些特殊代码,只能慢慢提升账号等级了。

问题应收录尽可能多的搜索词汇。既然你网站根基此时已经没有体重了,长尾收录和磕碰都是大话题。

重庆SEO关键字链接的分类和文章的情况怎么来优化

采集交流 • 优采云 发表了文章 • 0 个评论 • 87 次浏览 • 2021-08-09 21:05

我这里所说的关键字链接的唯一性是批量处理网站中某个关键字的URL链接,不是外链,一定要区分!

这里主要讲如何优化网站的分类和文章的标签和网站的主关键字!

很多朋友在写文章的时候有个习惯,就是用网站的关键词作为标签。比如我写了一篇文章文章,标签上写着:重庆SEO,但我不认识你。还没想好你的标签链接指向什么?如果碰巧是网站的主关键词,用重庆SEO这个词会怎么样?会有一个关键词对应两个不同因为我们都把主要的关键词指身网站首页,但是文章的标签是一个搜索集合,所以同一个词指的是链接的方法在不同的地方,我认为优化不是很理想!

网站的分类也是一样的。创建分类时要注意这个问题,尽量不要和网站的主关键字一样!

但是当这种情况不可避免地发生时,我们该怎么办。尤其是博客分类中的网站通常会在首页显示最新的文章,很多朋友都有调用文章的标签和文章的分类显示的习惯,并添加链接!

<p>其实你去一些前辈的网站就可以发现一个问题,站群software,他们也会有这种情况,不过他们已经处理过了,比如上面的例子,为什么他们可以,而我们不能?这是因为我们没有对链接进行处理,站群software,你会在他们的网站,这些TAG,或者类别是关键词的地方找到这些标签,他们没有添加链接,只是文本显示! 查看全部

重庆SEO关键字链接的分类和文章的情况怎么来优化

我这里所说的关键字链接的唯一性是批量处理网站中某个关键字的URL链接,不是外链,一定要区分!

这里主要讲如何优化网站的分类和文章的标签和网站的主关键字!

很多朋友在写文章的时候有个习惯,就是用网站的关键词作为标签。比如我写了一篇文章文章,标签上写着:重庆SEO,但我不认识你。还没想好你的标签链接指向什么?如果碰巧是网站的主关键词,用重庆SEO这个词会怎么样?会有一个关键词对应两个不同因为我们都把主要的关键词指身网站首页,但是文章的标签是一个搜索集合,所以同一个词指的是链接的方法在不同的地方,我认为优化不是很理想!

网站的分类也是一样的。创建分类时要注意这个问题,尽量不要和网站的主关键字一样!

但是当这种情况不可避免地发生时,我们该怎么办。尤其是博客分类中的网站通常会在首页显示最新的文章,很多朋友都有调用文章的标签和文章的分类显示的习惯,并添加链接!

<p>其实你去一些前辈的网站就可以发现一个问题,站群software,他们也会有这种情况,不过他们已经处理过了,比如上面的例子,为什么他们可以,而我们不能?这是因为我们没有对链接进行处理,站群software,你会在他们的网站,这些TAG,或者类别是关键词的地方找到这些标签,他们没有添加链接,只是文本显示!

阿里国际站采集产品视频不要再用工具的使用方法介绍

采集交流 • 优采云 发表了文章 • 0 个评论 • 455 次浏览 • 2021-08-09 02:04

如果您是没有货源的卖家,可以到阿里国际站找货源。产品种类丰富,价格优惠。您也可以将产品视频批量发送至电脑采集,更好的宣传产品。 采集不要再用传统的方式抓取产品视频了。建议使用第三方视频采集工具。很多电商朋友都在用。我可以帮你在短时间内提取采集大量产品视频。下一步是大家介绍这个工具的使用。

打开百度APP看高清图片

小编为大家推荐的采集video工具就是顾桥视频助手,专为电商朋友设计。 采集阿里国际站的产品视频效果如下:

第一步:打开下载好的古桥视频助手,在工具主页找到【电商视频下载】,点击进入。

第2步:打开阿里巴巴国际网站,搜索关键词浏览产品,遇到喜欢的产品点击进入,复制产品链接,然后粘贴到工具中,每行粘贴一个,并一次复制数百个视频链接,根据需要粘贴。

第三步:地址全部粘贴好后,返回工具主页面,在下载选项中设置需要采集的视频类型。这次采集主图视频。在工具下选择保存视频的位置,然后点击【立即下载】。

第 4 步:如果您有大量下载的视频,则需要稍等片刻。下载后,打开文件夹,就可以看到所有的视频了。视频非常清晰,非常适合素材。

借助谷桥视频助手,您可以下载各大电商平台的产品视频。操作步骤与阿里国际站产品video采集相同。 查看全部

阿里国际站采集产品视频不要再用工具的使用方法介绍

如果您是没有货源的卖家,可以到阿里国际站找货源。产品种类丰富,价格优惠。您也可以将产品视频批量发送至电脑采集,更好的宣传产品。 采集不要再用传统的方式抓取产品视频了。建议使用第三方视频采集工具。很多电商朋友都在用。我可以帮你在短时间内提取采集大量产品视频。下一步是大家介绍这个工具的使用。

打开百度APP看高清图片

小编为大家推荐的采集video工具就是顾桥视频助手,专为电商朋友设计。 采集阿里国际站的产品视频效果如下:

第一步:打开下载好的古桥视频助手,在工具主页找到【电商视频下载】,点击进入。

第2步:打开阿里巴巴国际网站,搜索关键词浏览产品,遇到喜欢的产品点击进入,复制产品链接,然后粘贴到工具中,每行粘贴一个,并一次复制数百个视频链接,根据需要粘贴。

第三步:地址全部粘贴好后,返回工具主页面,在下载选项中设置需要采集的视频类型。这次采集主图视频。在工具下选择保存视频的位置,然后点击【立即下载】。

第 4 步:如果您有大量下载的视频,则需要稍等片刻。下载后,打开文件夹,就可以看到所有的视频了。视频非常清晰,非常适合素材。

借助谷桥视频助手,您可以下载各大电商平台的产品视频。操作步骤与阿里国际站产品video采集相同。

第三方网站爬虫scrapy后端网站开发人员选择网站或自己的爬虫

采集交流 • 优采云 发表了文章 • 0 个评论 • 80 次浏览 • 2021-08-08 12:06

关键字采集文章评论采集校内论坛采集第三方网站爬虫第三方网站爬虫scrapy后端网站开发人员选择网站或自己的爬虫,需要遵循三大基本原则:1,一个爬虫就是一个程序,一个程序就是一个算法,一个算法就是一个闭环生态圈。2,爬虫任务的处理应该由自己处理。(类似于自己处理自己的问题)3,爬虫任务的负责人应该是自己!!!规定任务的每一个步骤!!!大家一定要通过严格的规划,完成自己认为正确的任务。有很多种通过json数据保存任务,发给一个网站请求给网站处理,然后返回一个json数据返回给我们。

“codingisdead.codingaregoinghome.”

学会了怎么用后台的scrapy。然后就是注意收集和发布节点的任务进度,

要学会爬虫算法、requests、各种模板引擎、scrapy的define方法等等,一定要学会requests、scrapy的define方法。学会看懂各种爬虫的api和配置。懂得爬虫机制,会有人加你进爬虫群,帮你爬站内站外内容。认真对待网站数据、网站数据的存储方式。至于兼容性、多线程等还是要慢慢补,然后你就能成为一个优秀的爬虫。总之开始学爬虫之前,一定要有一个想法,否则你也不会爬起来这么惨。

其实吧,有个爬虫学习社区非常好,从零开始系统全面的学爬虫,非常适合初学者。爬虫学习社区, 查看全部

第三方网站爬虫scrapy后端网站开发人员选择网站或自己的爬虫

关键字采集文章评论采集校内论坛采集第三方网站爬虫第三方网站爬虫scrapy后端网站开发人员选择网站或自己的爬虫,需要遵循三大基本原则:1,一个爬虫就是一个程序,一个程序就是一个算法,一个算法就是一个闭环生态圈。2,爬虫任务的处理应该由自己处理。(类似于自己处理自己的问题)3,爬虫任务的负责人应该是自己!!!规定任务的每一个步骤!!!大家一定要通过严格的规划,完成自己认为正确的任务。有很多种通过json数据保存任务,发给一个网站请求给网站处理,然后返回一个json数据返回给我们。

“codingisdead.codingaregoinghome.”

学会了怎么用后台的scrapy。然后就是注意收集和发布节点的任务进度,

要学会爬虫算法、requests、各种模板引擎、scrapy的define方法等等,一定要学会requests、scrapy的define方法。学会看懂各种爬虫的api和配置。懂得爬虫机制,会有人加你进爬虫群,帮你爬站内站外内容。认真对待网站数据、网站数据的存储方式。至于兼容性、多线程等还是要慢慢补,然后你就能成为一个优秀的爬虫。总之开始学爬虫之前,一定要有一个想法,否则你也不会爬起来这么惨。

其实吧,有个爬虫学习社区非常好,从零开始系统全面的学爬虫,非常适合初学者。爬虫学习社区,

修改后三、代码分析对无头设置进行了简单的修改

采集交流 • 优采云 发表了文章 • 0 个评论 • 104 次浏览 • 2021-08-07 02:02

修改后三、代码分析对无头设置进行了简单的修改

<a id="_0"></a>系列文章目录

<p>第一章:selenium实现爬虫功能selenium爬取图片实例

第二章:selenium实现增量式爬虫功能增量式爬虫

第三章:selenium搜索关键字爬虫

<a id="_17"></a>一、源代码

声名一下由于chrome的高级版本宣布不支持selenium所以博主将浏览器换成了Firefox。

import requests

from selenium import webdriver

import os

import pymysql

def hide():

options = webdriver.FirefoxOptions()

options.add_argument('-headless')

driver = webdriver.Firefox(options=options)

return driver

def Gethtml(url):

driver=hide()

driver.get(url)

s = driver.find_elements_by_css_selector("div[class='slist'] li a")

if str(s[-1].get_attribute("href")).split("/")[-2] == "4kmeinv":

geturl(s[:-1])

else:

geturl(s)

print(s[-1].get_attribute("href"))

Gethtml(s[-1].get_attribute("href"))

def huoqvpicture(url):

driver = webdriver.Chrome(options=hide())

driver.get(url)

s=driver.find_element_by_css_selector("div[class='photo-pic'] a img")

print(s.get_attribute("title"))

insert(url,s.get_attribute("src"),s.get_attribute("title"))

GetPicture(str(s.get_attribute("src")),str(s.get_attribute("title")))

def GetPicture(url,name):

root = "../dist/"

path =root + name.replace(" ","")+".jpg"

try:

if not os.path.exists(root):

os.mkdir(root)

if not os.path.exists(path):

r = requests.get(url)

with open(path, 'wb') as f:

f.write(r.content)

f.close()

print("文件保存成功")

else:

print("文件已存在")

except:

print("爬取失败")

def geturl(s):

for i in s:

print(i.get_attribute("href"))

if not qvchong(i.get_attribute("href")):

huoqvpicture(str(i.get_attribute("href")))

def insert(html,jpg,name):

con = pymysql.connect(host="121.196.244.215", user="root", password="123456" ,port=3306 ,db="tupian",charset="utf8")

cur=con.cursor()

html=str(html)

jpg=str(jpg)

name=str(name)

sql="insert into suoyin(html,jpg,name) values('"+html+"','"+jpg+"','"+name+"');"

print("sql")

#cur.execute(sql)

con.commit()

def qvchong(i):

con = pymysql.connect(host="121.196.244.215", user="root", password="123456", port=3306, db="tupian",

charset="utf8")

cur=con.cursor()

sql="select html from suoyin"

cur.execute(sql)

results = cur.fetchall()

i=(str(i),)

if i in results:

print("数据已存在")

return True

else:

return False

def main():

url="https://pic.netbian.com/4kmeinv/index.html"

Gethtml(url)

main()

</p>

二、修改后

import requests

from selenium import webdriver

import os

import pymysql

import time

def hide():

options = webdriver.FirefoxOptions()

options.add_argument('-headless')

driver = webdriver.Firefox(options=options)

return driver

def huoqvpicture(url):

driver = hide()

driver.get(url)

s=driver.find_element_by_css_selector("div[class='photo-pic'] a img")

print(s.get_attribute("title"))

insert(url,s.get_attribute("src"),s.get_attribute("title"))

GetPicture(str(s.get_attribute("src")),str(s.get_attribute("title")))

driver.close()

def GetPicture(url,name):

root = "../dist/"

path =root + name.replace(" ","")+".jpg"

try:

if not os.path.exists(root):

os.mkdir(root)

if not os.path.exists(path):

r = requests.get(url)

with open(path, 'wb') as f:

f.write(r.content)

f.close()

print("文件保存成功")

else:

print("文件已存在")

except:

print("爬取失败")

def geturl(s):

for i in s:

print(i.get_attribute("href"))

if not qvchong(i.get_attribute("href")):

huoqvpicture(str(i.get_attribute("href")))

def insert(html,jpg,name):

con = pymysql.connect(host="121.196.244.215", user="root", password="123456" ,port=3306 ,db="tupian",charset="utf8")

cur=con.cursor()

html=str(html)

jpg=str(jpg)

name=qvdian(str(name))

sql="insert into suoyin(html,jpg,name) values('"+html+"','"+jpg+"','"+name+"');"

print("插入一条数据")

cur.execute(sql)

con.commit()

def qvchong(i):

con = pymysql.connect(host="121.196.244.215", user="root", password="123456", port=3306, db="tupian",

charset="utf8")

cur=con.cursor()

sql="select html from suoyin"

cur.execute(sql)

results = cur.fetchall()

i=(str(i),)

if i in results:

print("数据已存在")

return True

else:

return False

def geisuo(driver,a):

s = driver.find_elements_by_css_selector("div[class='slist'] li a")

print(a)

a = a + 1

if str(s[-1].get_attribute("href")).split("/")[-2] == "result":

geturl(s[:-1])

else:

geturl(s)

bt=driver.find_element_by_class_name("nextpage")

bt.click()

geisuo(driver,a)

def click(url):

driver = hide()

driver.implicitly_wait(3)

driver.get(url)

keyboard = driver.find_element_by_name("keyboard")

time.sleep(1)

keyboard.send_keys("美女")

bt = driver.find_element_by_name("submit")

time.sleep(1)

bt.click()

geisuo(driver,1)

def qvdian(s):

s=str(s)

ls=s.split("'")

s="".join(ls)

return s

def main():

url="https://pic.netbian.com/e/sear ... ot%3B

click(url)

main()

三、代码分析

def hide():

options = webdriver.FirefoxOptions()

options.add_argument('-headless')

driver = webdriver.Firefox(options=options)

return driver

更改浏览器后对headless设置的简单修改,现在直接返回浏览器,提高代码运行效率。

def click(url):

driver = hide() #创建无头浏览器

driver.implicitly_wait(3) #设计浏览器等待时间

driver.get(url) #获取html页面

keyboard = driver.find_element_by_name("keyboard")

#找到搜索框

time.sleep(1) #等待1秒(拟人化操作)

keyboard.send_keys("美女")

#搜索框输入相应的关键字

bt = driver.find_element_by_name("submit")

#找到搜索按钮

time.sleep(1) #等待1秒(拟人化操作)

bt.click() #点击搜索按钮

geisuo(driver,1) #将浏览器和页数作为参数传递

这段代码可以说是整个新增代码中的核心代码,他负责关键字搜索。

def geisuo(driver,a):

s = driver.find_elements_by_css_selector("div[class='slist'] li a") #获取相关的url(最后一个是下一页)

print(a) #打印当前页页数,方便人了解进度

a = a + 1 #页数加一

if str(s[-1].get_attribute("href")).split("/")[-2] == "result":

#查看是否到达最后一页

geturl(s[:-1])

#除最后一个进行爬取(未到达最后一页)

else:

geturl(s)

#全部爬取(到达最后一页)

bt=driver.find_element_by_class_name("nextpage")

#找到下一页的点击按钮,进行翻页

bt.click()

#点击下一页

geisuo(driver,a)

#调用自身重新获取数据

以前,翻页是通过重新获取url来完成的。这次使用的是鼠标点击。

def huoqvpicture(url):

driver = hide()

driver.get(url)

s=driver.find_element_by_css_selector("div[class='photo-pic'] a img")

print(s.get_attribute("title"))

insert(url,s.get_attribute("src"),s.get_attribute("title"))

GetPicture(str(s.get_attribute("src")),str(s.get_attribute("title")))

driver.close() #关掉浏览器,节省内存

建议大家写完代码后开启headless模式。博主会打开浏览器,之前不用爬图。不知道有没有开启headless模式,消耗内存。

def qvdian(s):

s=str(s) #将述据转化为字符串

ls=s.split("'") #以单引号为边界切开

s="".join(ls) #在直接合并成字符串

return s

数据插入数据库时,如果有'in',则插入失败,写个小函数去掉单引号,修复一个bug。

总结

selenium 的大部分知识到此结束。博主开始学习爬虫框架scrapy。学习之后,基本上把python的爬虫内容都学完了,selinium文章就结束了。 查看全部

修改后三、代码分析对无头设置进行了简单的修改

<a id="_0"></a>系列文章目录

<p>第一章:selenium实现爬虫功能selenium爬取图片实例

第二章:selenium实现增量式爬虫功能增量式爬虫

第三章:selenium搜索关键字爬虫

<a id="_17"></a>一、源代码

声名一下由于chrome的高级版本宣布不支持selenium所以博主将浏览器换成了Firefox。

import requests

from selenium import webdriver

import os

import pymysql

def hide():

options = webdriver.FirefoxOptions()

options.add_argument('-headless')

driver = webdriver.Firefox(options=options)

return driver

def Gethtml(url):

driver=hide()

driver.get(url)

s = driver.find_elements_by_css_selector("div[class='slist'] li a")

if str(s[-1].get_attribute("href")).split("/")[-2] == "4kmeinv":

geturl(s[:-1])

else:

geturl(s)

print(s[-1].get_attribute("href"))

Gethtml(s[-1].get_attribute("href"))

def huoqvpicture(url):

driver = webdriver.Chrome(options=hide())

driver.get(url)

s=driver.find_element_by_css_selector("div[class='photo-pic'] a img")

print(s.get_attribute("title"))

insert(url,s.get_attribute("src"),s.get_attribute("title"))

GetPicture(str(s.get_attribute("src")),str(s.get_attribute("title")))

def GetPicture(url,name):

root = "../dist/"

path =root + name.replace(" ","")+".jpg"

try:

if not os.path.exists(root):

os.mkdir(root)

if not os.path.exists(path):

r = requests.get(url)

with open(path, 'wb') as f:

f.write(r.content)

f.close()

print("文件保存成功")

else:

print("文件已存在")

except:

print("爬取失败")

def geturl(s):

for i in s:

print(i.get_attribute("href"))

if not qvchong(i.get_attribute("href")):

huoqvpicture(str(i.get_attribute("href")))

def insert(html,jpg,name):

con = pymysql.connect(host="121.196.244.215", user="root", password="123456" ,port=3306 ,db="tupian",charset="utf8")

cur=con.cursor()

html=str(html)

jpg=str(jpg)

name=str(name)

sql="insert into suoyin(html,jpg,name) values('"+html+"','"+jpg+"','"+name+"');"

print("sql")

#cur.execute(sql)

con.commit()

def qvchong(i):

con = pymysql.connect(host="121.196.244.215", user="root", password="123456", port=3306, db="tupian",

charset="utf8")

cur=con.cursor()

sql="select html from suoyin"

cur.execute(sql)

results = cur.fetchall()

i=(str(i),)

if i in results:

print("数据已存在")

return True

else:

return False

def main():

url="https://pic.netbian.com/4kmeinv/index.html"

Gethtml(url)

main()

</p>

二、修改后

import requests

from selenium import webdriver

import os

import pymysql

import time

def hide():

options = webdriver.FirefoxOptions()

options.add_argument('-headless')

driver = webdriver.Firefox(options=options)

return driver

def huoqvpicture(url):

driver = hide()

driver.get(url)

s=driver.find_element_by_css_selector("div[class='photo-pic'] a img")

print(s.get_attribute("title"))

insert(url,s.get_attribute("src"),s.get_attribute("title"))

GetPicture(str(s.get_attribute("src")),str(s.get_attribute("title")))

driver.close()

def GetPicture(url,name):

root = "../dist/"

path =root + name.replace(" ","")+".jpg"

try:

if not os.path.exists(root):

os.mkdir(root)

if not os.path.exists(path):

r = requests.get(url)

with open(path, 'wb') as f:

f.write(r.content)

f.close()

print("文件保存成功")

else:

print("文件已存在")

except:

print("爬取失败")

def geturl(s):

for i in s:

print(i.get_attribute("href"))

if not qvchong(i.get_attribute("href")):

huoqvpicture(str(i.get_attribute("href")))

def insert(html,jpg,name):

con = pymysql.connect(host="121.196.244.215", user="root", password="123456" ,port=3306 ,db="tupian",charset="utf8")

cur=con.cursor()

html=str(html)

jpg=str(jpg)

name=qvdian(str(name))

sql="insert into suoyin(html,jpg,name) values('"+html+"','"+jpg+"','"+name+"');"

print("插入一条数据")

cur.execute(sql)

con.commit()

def qvchong(i):

con = pymysql.connect(host="121.196.244.215", user="root", password="123456", port=3306, db="tupian",

charset="utf8")

cur=con.cursor()

sql="select html from suoyin"

cur.execute(sql)

results = cur.fetchall()

i=(str(i),)

if i in results:

print("数据已存在")

return True

else:

return False

def geisuo(driver,a):

s = driver.find_elements_by_css_selector("div[class='slist'] li a")

print(a)

a = a + 1

if str(s[-1].get_attribute("href")).split("/")[-2] == "result":

geturl(s[:-1])

else:

geturl(s)

bt=driver.find_element_by_class_name("nextpage")

bt.click()

geisuo(driver,a)

def click(url):

driver = hide()

driver.implicitly_wait(3)

driver.get(url)

keyboard = driver.find_element_by_name("keyboard")

time.sleep(1)

keyboard.send_keys("美女")

bt = driver.find_element_by_name("submit")

time.sleep(1)

bt.click()

geisuo(driver,1)

def qvdian(s):

s=str(s)

ls=s.split("'")

s="".join(ls)

return s

def main():

url="https://pic.netbian.com/e/sear ... ot%3B

click(url)

main()

三、代码分析

def hide():

options = webdriver.FirefoxOptions()

options.add_argument('-headless')

driver = webdriver.Firefox(options=options)

return driver

更改浏览器后对headless设置的简单修改,现在直接返回浏览器,提高代码运行效率。

def click(url):

driver = hide() #创建无头浏览器

driver.implicitly_wait(3) #设计浏览器等待时间

driver.get(url) #获取html页面