全网文章 采集

全网文章 采集(采集规则是什么,不懂采集插件可以进行网站采集吗 )

采集交流 • 优采云 发表了文章 • 0 个评论 • 128 次浏览 • 2022-03-12 23:02

)

采集什么是规则,如果我不理解采集规则,我可以做网站采集。像我们的许多新手站长一样,博主在第一次接触 网站采集 时总会遇到听起来很复杂的正则表达式之类的规则 采集。虽然博主还一窍不通,但不影响我通过无规则采集插件完成网站data采集。

无规则采集插件操作过程可视化,无需掌握复杂的采集规则,操作页面简单,一眼就能上手,无论是图片手机或者一个自媒体论坛,整个过程可视化,满足各种采集需求。只需要关键词输入即可实现全网采集。

无规则采集插件的增量指定采集只要输入我们需要的URL采集,在插件窗口点击我们需要的采集元素就可以启动我们的数据和内容采集。采集之后的内容支持txt、html、小滚动样式保存到本地

采集规则的设置其实是为了让我们获取对我们有用的数据和内容。比如我们可以在插件中点击过滤作者信息、去除图片水印、过滤广告等。让我们采集内容干净整洁,方便我们二次加工。

当然还有一点很重要,就是采集网站标签的保留。我们的网页代码中会用到一些标签,这些标签可以用来方便蜘蛛抓取。因此,在采集过程中保留原创标签也很重要。当然,并不是所有的标签都需要保留,这些也是可选的。下面我们来看看如何巧妙地使用标签。

1、内容标签

内容标签的作用是强调文本,浏览器一般使用粗体字来表示标签的内容。

2、标题标签

标题标签定义了网页 HTML 代码中的标题。在所有页面中,博主建议该标签具有且只需要出现一次。可以定义标题,权重按降序排列。除了标签,其他标签可以重复出现。

3、alt 属性标签

准确的说应该是标签的alt属性。如果显示在网站上,也就是用户将鼠标放在图片上,浏览器会自动显示一个文本框给图片加文字。描述。我们都知道蜘蛛是不可能识别出网站中的图片的,但是如果我们在图片上加一些代码,那么就可以让蜘蛛完成对图片的一些识别,可以理解为识别图片的。一定的描述,让蜘蛛能够理解图片中的信息。当然,从关键词的角度来看,添加标签可以提高整个页面的关键词密度。

4、不关注标签

nofollow 标签是 SEO 中非常重要的标签。它的目的是告诉蜘蛛不要跟随这个页面上的链接,或者不要跟随这个特定的链接。它通常用于不在本网站上的链接。例如,我们可以将一个页面视为一个桶,而链接则是桶中的一个洞。如果桶的顶部没有孔,那么桶可以将所有的水都储存在里面。如果桶中的孔洞很多,会导致桶中的水快速流失。给链接加上nofollow标签,就相当于修补了这些漏洞,让蜘蛛不会跟随这些链接。

不通过采集规则的网站数据和文章采集的共享到此结束。当然,免规则采集不仅有标签保留等功能,文章采集@文章伪原创,图片加水印等也可以使用. 本文主要介绍采集规则中大家比较关心的几个问题。标签的保留可以降低我们二次创作的难度。相关优化提高了我们的 文章原创 度数。整个网站的优化就是通过这些小细节一点一点打造的。所以在网站优化的过程中也要注意细节,分享就到这里,欢迎一键连接!

查看全部

全网文章 采集(采集规则是什么,不懂采集插件可以进行网站采集吗

)

采集什么是规则,如果我不理解采集规则,我可以做网站采集。像我们的许多新手站长一样,博主在第一次接触 网站采集 时总会遇到听起来很复杂的正则表达式之类的规则 采集。虽然博主还一窍不通,但不影响我通过无规则采集插件完成网站data采集。

无规则采集插件操作过程可视化,无需掌握复杂的采集规则,操作页面简单,一眼就能上手,无论是图片手机或者一个自媒体论坛,整个过程可视化,满足各种采集需求。只需要关键词输入即可实现全网采集。

无规则采集插件的增量指定采集只要输入我们需要的URL采集,在插件窗口点击我们需要的采集元素就可以启动我们的数据和内容采集。采集之后的内容支持txt、html、小滚动样式保存到本地

采集规则的设置其实是为了让我们获取对我们有用的数据和内容。比如我们可以在插件中点击过滤作者信息、去除图片水印、过滤广告等。让我们采集内容干净整洁,方便我们二次加工。

当然还有一点很重要,就是采集网站标签的保留。我们的网页代码中会用到一些标签,这些标签可以用来方便蜘蛛抓取。因此,在采集过程中保留原创标签也很重要。当然,并不是所有的标签都需要保留,这些也是可选的。下面我们来看看如何巧妙地使用标签。

1、内容标签

内容标签的作用是强调文本,浏览器一般使用粗体字来表示标签的内容。

2、标题标签

标题标签定义了网页 HTML 代码中的标题。在所有页面中,博主建议该标签具有且只需要出现一次。可以定义标题,权重按降序排列。除了标签,其他标签可以重复出现。

3、alt 属性标签

准确的说应该是标签的alt属性。如果显示在网站上,也就是用户将鼠标放在图片上,浏览器会自动显示一个文本框给图片加文字。描述。我们都知道蜘蛛是不可能识别出网站中的图片的,但是如果我们在图片上加一些代码,那么就可以让蜘蛛完成对图片的一些识别,可以理解为识别图片的。一定的描述,让蜘蛛能够理解图片中的信息。当然,从关键词的角度来看,添加标签可以提高整个页面的关键词密度。

4、不关注标签

nofollow 标签是 SEO 中非常重要的标签。它的目的是告诉蜘蛛不要跟随这个页面上的链接,或者不要跟随这个特定的链接。它通常用于不在本网站上的链接。例如,我们可以将一个页面视为一个桶,而链接则是桶中的一个洞。如果桶的顶部没有孔,那么桶可以将所有的水都储存在里面。如果桶中的孔洞很多,会导致桶中的水快速流失。给链接加上nofollow标签,就相当于修补了这些漏洞,让蜘蛛不会跟随这些链接。

不通过采集规则的网站数据和文章采集的共享到此结束。当然,免规则采集不仅有标签保留等功能,文章采集@文章伪原创,图片加水印等也可以使用. 本文主要介绍采集规则中大家比较关心的几个问题。标签的保留可以降低我们二次创作的难度。相关优化提高了我们的 文章原创 度数。整个网站的优化就是通过这些小细节一点一点打造的。所以在网站优化的过程中也要注意细节,分享就到这里,欢迎一键连接!

全网文章 采集(利用白帽SEO优化方法快速提升网站权重值的方法有哪些)

采集交流 • 优采云 发表了文章 • 0 个评论 • 110 次浏览 • 2022-02-28 19:25

文章采集,让网站有内容,只有有内容才有收录,收录才有条件提升网站重量。网站权重是对网站综合价值的总称,包括网站运营能力、用户体验、内容质量、用户热度、SEO指标。综合性能统一名称。

文章采集如何增加网站的权重:日常正规管理和操作网站,使用正规白帽方法操作网站,比如更新内容,检查和维护操作等。这些都是站长必须做的事情。挖矿优化精准关键词,根据自己的网站行业,挖矿优化精准网站关键词,必须有流量关键词,如果挖矿关键词@ >与网站的主题定位无关,那么网站的权重就很难增加,甚至网站都会被搜索引擎惩罚。

文章采集改进网站和收录的内容,网站收录索引数据与网站@的更新次数成正比> content 是的,如果你长时间不更新网站,那么你的网站索引数据不仅会增加,还会减少。如果你想改进网站收录的内容,那么你需要不断更新网站优质内容。

同时,站内和站外的SEO也需要做好。除了文章采集,还要更新内容,内链优化,网站结构优化,404、网站sitemap地图和机器人都是都在现场搜索引擎优化的范畴。如果你不做好站内优化,你的外链再好也没用,因为你的网站留不住用户,所以站内优化大于站外-网站优化,而外部链接的作用近年来逐渐减弱。如果想通过累计外链数量来增加网站的权重,目前可能很难实现。

使用白帽SEO进行形式优化,为什么一定要使用白帽SEO来优化网站?因为有的站长想用黑帽SEO优化的方法来快速提升网站的权重值,如果使用这些黑帽SEO,一旦被搜索引擎发现,就等待网站@的结果> 只能被惩罚或K站。搜索引擎支持用户使用正式的白帽SEO优化方式,因为这种优化方式可以持续为用户提供有价值的内容。

我们在优化网站的时候,建议不要用黑帽作弊来优化网站,因为到最后你很可能会花费时间和精力,却没有网站好的流量。

<p>新站前期以文章采集和挖矿网站长尾关键词为主。长尾关键词不仅竞争程度低,而且排名时间短。优化长尾关键词可能只需要几个星期,最长不会超过一个月。新站没有优化基础,搜索引擎对新站信任度不高。我们优化关键词@文章采集和长尾关键词,可以实现更快的收录网站页面,更快的流量,然后不断的积累和提高网站的流量和权重,最后为了争夺一些高指数、高流量的关键词,新的网站倾向于前期做内容, 查看全部

全网文章 采集(利用白帽SEO优化方法快速提升网站权重值的方法有哪些)

文章采集,让网站有内容,只有有内容才有收录,收录才有条件提升网站重量。网站权重是对网站综合价值的总称,包括网站运营能力、用户体验、内容质量、用户热度、SEO指标。综合性能统一名称。

文章采集如何增加网站的权重:日常正规管理和操作网站,使用正规白帽方法操作网站,比如更新内容,检查和维护操作等。这些都是站长必须做的事情。挖矿优化精准关键词,根据自己的网站行业,挖矿优化精准网站关键词,必须有流量关键词,如果挖矿关键词@ >与网站的主题定位无关,那么网站的权重就很难增加,甚至网站都会被搜索引擎惩罚。

文章采集改进网站和收录的内容,网站收录索引数据与网站@的更新次数成正比> content 是的,如果你长时间不更新网站,那么你的网站索引数据不仅会增加,还会减少。如果你想改进网站收录的内容,那么你需要不断更新网站优质内容。

同时,站内和站外的SEO也需要做好。除了文章采集,还要更新内容,内链优化,网站结构优化,404、网站sitemap地图和机器人都是都在现场搜索引擎优化的范畴。如果你不做好站内优化,你的外链再好也没用,因为你的网站留不住用户,所以站内优化大于站外-网站优化,而外部链接的作用近年来逐渐减弱。如果想通过累计外链数量来增加网站的权重,目前可能很难实现。

使用白帽SEO进行形式优化,为什么一定要使用白帽SEO来优化网站?因为有的站长想用黑帽SEO优化的方法来快速提升网站的权重值,如果使用这些黑帽SEO,一旦被搜索引擎发现,就等待网站@的结果> 只能被惩罚或K站。搜索引擎支持用户使用正式的白帽SEO优化方式,因为这种优化方式可以持续为用户提供有价值的内容。

我们在优化网站的时候,建议不要用黑帽作弊来优化网站,因为到最后你很可能会花费时间和精力,却没有网站好的流量。

<p>新站前期以文章采集和挖矿网站长尾关键词为主。长尾关键词不仅竞争程度低,而且排名时间短。优化长尾关键词可能只需要几个星期,最长不会超过一个月。新站没有优化基础,搜索引擎对新站信任度不高。我们优化关键词@文章采集和长尾关键词,可以实现更快的收录网站页面,更快的流量,然后不断的积累和提高网站的流量和权重,最后为了争夺一些高指数、高流量的关键词,新的网站倾向于前期做内容,

全网文章 采集(全网文章采集策略实现爬虫,把你喜欢的文章)

采集交流 • 优采云 发表了文章 • 0 个评论 • 125 次浏览 • 2022-02-27 01:01

全网文章采集抓取,把你喜欢的文章按照标题、作者、类型、摘要进行汇总分析。文章采集策略实现爬虫,抓取全网高质量的文章及网站全部内容。

是需要找个国外的it公司的top10的网站的内容进行抓取,如果不方便的话我建议使用系统自带的api,因为在手机端自己去抓取的话可能会有各种的杂乱问题或者遗漏数据。我们团队用scrapy+webdriver做了一套网页爬虫。我自己编写的爬虫如下:代码如下:爬虫:github-zengwxjj/scrapy:scrapyutilityforpython,java,php,ruby,f#,mysql,sqlite,sqlitemysqlserver,oracle,mysql,db2,access,impala,postgresql,oracle,hadoopandmapreduce-java//获取全网数据抓取,增强db的功能,爬取web蜘蛛端的tokens,数据字典和sql解析scrapy-db功能保存sitetokens,json,jsonp,xml,jsonpath爬取信息myblogajax-ajax保存重定向代码:python的db还支持动态sql语句===我发现我太激动了,已经脱离苦海,立刻让anna大大来救我回去=anna大大欢迎您参与反爬不挂乎。 查看全部

全网文章 采集(全网文章采集策略实现爬虫,把你喜欢的文章)

全网文章采集抓取,把你喜欢的文章按照标题、作者、类型、摘要进行汇总分析。文章采集策略实现爬虫,抓取全网高质量的文章及网站全部内容。

是需要找个国外的it公司的top10的网站的内容进行抓取,如果不方便的话我建议使用系统自带的api,因为在手机端自己去抓取的话可能会有各种的杂乱问题或者遗漏数据。我们团队用scrapy+webdriver做了一套网页爬虫。我自己编写的爬虫如下:代码如下:爬虫:github-zengwxjj/scrapy:scrapyutilityforpython,java,php,ruby,f#,mysql,sqlite,sqlitemysqlserver,oracle,mysql,db2,access,impala,postgresql,oracle,hadoopandmapreduce-java//获取全网数据抓取,增强db的功能,爬取web蜘蛛端的tokens,数据字典和sql解析scrapy-db功能保存sitetokens,json,jsonp,xml,jsonpath爬取信息myblogajax-ajax保存重定向代码:python的db还支持动态sql语句===我发现我太激动了,已经脱离苦海,立刻让anna大大来救我回去=anna大大欢迎您参与反爬不挂乎。

全网文章 采集(服务器的常规操作应该是怎样的?-全网)

采集交流 • 优采云 发表了文章 • 0 个评论 • 122 次浏览 • 2022-02-22 10:00

全网文章采集:微信公众号:wisdom-linked,知乎专栏:;希望有助于你的理解。注意,

举例read_info把所有自己感兴趣的数据read进来做筛选

1.代码md5加密;这个也可以用第三方库:secretjs。2.自己写js插件。

通过常规方法是是通过js插件来进行处理,但是如果你是公司内部服务器,基本上没有太大的意义。

服务器的常规操作应该也是这样的步骤:1.获取cookie/注册cookie(第三方服务例如jwt或者sessionforever)2.显示相关html内容

一般跟登录一样,如果你自己写js插件的话,可以自己写一个程序通过cookie对原本的cookie进行加密生成apikey,然后通过apikey对服务器的数据库进行提取,然后匹配出相应的就是你想要的数据了。有些公司有需求就会自己出此类相关的接口,

这要算防破解的话,其实生活中我们这一行也有防破解的东西。还有个应用,貌似叫p2p。平时一些无线传输还有你通过wifi连接上,然后数据传输也都会破解的。

你这么想想,这里还是用java来写。首先我们要先进行api接口注册获取访问许可,接着要明确安全认证的模式,nginx做nginx的反向代理认证机制,然后就是浏览器或者lnmp服务器做端口映射与v4.7及更高版本的ssl加密。同时可以考虑用一些比较好的cookie接收服务器进行嗅探。只要找到nginx或者其他服务器,让它的程序去请求这个应用就行了。

要是面试的话。可以说。ssh会什么就能干什么。可以是windows\aix\linux\x11\x12等等。 查看全部

全网文章 采集(服务器的常规操作应该是怎样的?-全网)

全网文章采集:微信公众号:wisdom-linked,知乎专栏:;希望有助于你的理解。注意,

举例read_info把所有自己感兴趣的数据read进来做筛选

1.代码md5加密;这个也可以用第三方库:secretjs。2.自己写js插件。

通过常规方法是是通过js插件来进行处理,但是如果你是公司内部服务器,基本上没有太大的意义。

服务器的常规操作应该也是这样的步骤:1.获取cookie/注册cookie(第三方服务例如jwt或者sessionforever)2.显示相关html内容

一般跟登录一样,如果你自己写js插件的话,可以自己写一个程序通过cookie对原本的cookie进行加密生成apikey,然后通过apikey对服务器的数据库进行提取,然后匹配出相应的就是你想要的数据了。有些公司有需求就会自己出此类相关的接口,

这要算防破解的话,其实生活中我们这一行也有防破解的东西。还有个应用,貌似叫p2p。平时一些无线传输还有你通过wifi连接上,然后数据传输也都会破解的。

你这么想想,这里还是用java来写。首先我们要先进行api接口注册获取访问许可,接着要明确安全认证的模式,nginx做nginx的反向代理认证机制,然后就是浏览器或者lnmp服务器做端口映射与v4.7及更高版本的ssl加密。同时可以考虑用一些比较好的cookie接收服务器进行嗅探。只要找到nginx或者其他服务器,让它的程序去请求这个应用就行了。

要是面试的话。可以说。ssh会什么就能干什么。可以是windows\aix\linux\x11\x12等等。

全网文章 采集(极客邦新产品——极客搜索,整合技术文章资源)

采集交流 • 优采云 发表了文章 • 0 个评论 • 145 次浏览 • 2022-02-20 12:30

最近Geekbang发布了一款新产品——Geek Search,它整合了Geekbang下面的技术文章资源。抱着尝鲜的态度,我也试了一下,发现搜索速度很快。分析了为什么这么快,主要有两点:1、资源太少了!!!,12个公众号加起来5161篇文章;2、使用Vue框架,异步加载数据。这个产品还是很好用的,推荐一下,希望能尽快添加可搜索的技术资源。

最近在想采集some文章做分词。接口是vue写的,所以所有的数据都要经过接口,所以数据采集很方便,所以一时兴起,趁着产品刚刚上线,防爬机制不应该强,所以我采集Geekbang的所有公众号数据。一:文章采集

主要分为两个步骤,采集文章链接和原文采集。

1、采集文章链接,通过搜索界面,抓取所有文章链接

从返回的数据中可以抓取到文章原文的链接,接下来就是链接到采集原文的数据了。

2、原创资料采集

使用scrapy框架对采集微信文章数据,共采集5151篇文章。

具体代码见文末地址

二:数据分析

接下来,我对采集的文章做了一些简单的统计。

1、哪个公众号写的最多文章

infoQ 写的文章最多,998 篇,占 19.35%。StuQ以835篇排名第二,占比16.19%,EGONetworks以802篇排名第三,占比15.55%。这三个部分恰好是极客科技的三大业务。

2、每天文章 帖子的总数

随着运营的公众号越来越多,文章的数量不断攀升,2017年达到每月250多个,编辑能力非常强大。

统计每天发布文章的数量:非常规律,周一到周五多,周六周日少。那些在周六和周日努力工作的人。

3、文章词频统计

对所有文章进行分词,然后统计词频。

Top 10:我们、一、数据、技术、能、服务、使用、需要、问题、系统

前 10 个单词是:我们需要一个系统来解决技术或数据问题。是在暗示什么吗?我可以开发一个供您使用吗?商机就在这里。由于分词的结果还没有调整,所以有很多常用的修饰语等等。以后再做是一项体力消耗大的工作。

4、作者统计

基于 文章 的作者的统计。前 10 名:StuQ、EGO、InfoQ、徐川、大家硕、陈圆圆、Q News、Indigo K & Guo Liang、Stark Academy、Daniel V Classroom。

5、文章头条新闻

文章标题的命名也反映了时间的趋势,所以我把文章的标题全部提取出来,做了分词,自定义jieba的字典,去掉了很多修饰符等等,得到了下面的结果。

2015年:技术排名第一,这也符合Geekbang的特点。微直播和微课堂的提及很多,主要是因为StuQ的公众号上的广告太多了。当然,你也可以看到一些过去的流行词,比如互联网金融、大数据、创业、容器技术等。

2016年:技术依旧稳居第一,云计算、开源等词出现,也出现了阿里、AWS、百度、京东等国内大公司。

2017:变化离不开技术。同时,机器学习、深度学习、人工智能、AI等词汇的使用量有所增加,符合当下的学习热潮。

从标题文章的命名来看,极客帮微信公众号的内容基本紧跟最新科技潮流。把握技术发展趋势,分析头条。

三:总结

本文的主要工作是数据采集和分析。对于数据采集,难度不大,用scrapy可以很快搞定。数据分析很费时间,我只做了一些简单的统计。后续会在数据的基础上做一些文本相关性分析。

数据的展示地址,源码也已经放到github上,crawler-geekbang/geekbang at master·xuxping/crawler-geekbang·GitHub 查看全部

全网文章 采集(极客邦新产品——极客搜索,整合技术文章资源)

最近Geekbang发布了一款新产品——Geek Search,它整合了Geekbang下面的技术文章资源。抱着尝鲜的态度,我也试了一下,发现搜索速度很快。分析了为什么这么快,主要有两点:1、资源太少了!!!,12个公众号加起来5161篇文章;2、使用Vue框架,异步加载数据。这个产品还是很好用的,推荐一下,希望能尽快添加可搜索的技术资源。

最近在想采集some文章做分词。接口是vue写的,所以所有的数据都要经过接口,所以数据采集很方便,所以一时兴起,趁着产品刚刚上线,防爬机制不应该强,所以我采集Geekbang的所有公众号数据。一:文章采集

主要分为两个步骤,采集文章链接和原文采集。

1、采集文章链接,通过搜索界面,抓取所有文章链接

从返回的数据中可以抓取到文章原文的链接,接下来就是链接到采集原文的数据了。

2、原创资料采集

使用scrapy框架对采集微信文章数据,共采集5151篇文章。

具体代码见文末地址

二:数据分析

接下来,我对采集的文章做了一些简单的统计。

1、哪个公众号写的最多文章

infoQ 写的文章最多,998 篇,占 19.35%。StuQ以835篇排名第二,占比16.19%,EGONetworks以802篇排名第三,占比15.55%。这三个部分恰好是极客科技的三大业务。

2、每天文章 帖子的总数

随着运营的公众号越来越多,文章的数量不断攀升,2017年达到每月250多个,编辑能力非常强大。

统计每天发布文章的数量:非常规律,周一到周五多,周六周日少。那些在周六和周日努力工作的人。

3、文章词频统计

对所有文章进行分词,然后统计词频。

Top 10:我们、一、数据、技术、能、服务、使用、需要、问题、系统

前 10 个单词是:我们需要一个系统来解决技术或数据问题。是在暗示什么吗?我可以开发一个供您使用吗?商机就在这里。由于分词的结果还没有调整,所以有很多常用的修饰语等等。以后再做是一项体力消耗大的工作。

4、作者统计

基于 文章 的作者的统计。前 10 名:StuQ、EGO、InfoQ、徐川、大家硕、陈圆圆、Q News、Indigo K & Guo Liang、Stark Academy、Daniel V Classroom。

5、文章头条新闻

文章标题的命名也反映了时间的趋势,所以我把文章的标题全部提取出来,做了分词,自定义jieba的字典,去掉了很多修饰符等等,得到了下面的结果。

2015年:技术排名第一,这也符合Geekbang的特点。微直播和微课堂的提及很多,主要是因为StuQ的公众号上的广告太多了。当然,你也可以看到一些过去的流行词,比如互联网金融、大数据、创业、容器技术等。

2016年:技术依旧稳居第一,云计算、开源等词出现,也出现了阿里、AWS、百度、京东等国内大公司。

2017:变化离不开技术。同时,机器学习、深度学习、人工智能、AI等词汇的使用量有所增加,符合当下的学习热潮。

从标题文章的命名来看,极客帮微信公众号的内容基本紧跟最新科技潮流。把握技术发展趋势,分析头条。

三:总结

本文的主要工作是数据采集和分析。对于数据采集,难度不大,用scrapy可以很快搞定。数据分析很费时间,我只做了一些简单的统计。后续会在数据的基础上做一些文本相关性分析。

数据的展示地址,源码也已经放到github上,crawler-geekbang/geekbang at master·xuxping/crawler-geekbang·GitHub

全网文章 采集(网址早期要想百度收录和排行速率不清除会出现)

采集交流 • 优采云 发表了文章 • 0 个评论 • 101 次浏览 • 2022-02-19 07:07

在网站早期,如果百度收录和排名率没有迅速清零,相关领域的内容文章会大量采集。很多网站站长尝试的结果是,早期适当采集了一些文章内容来提高文章内容的字数,但是一味的采集太多文章并发布会对大家的网站造成非常严重的不良影响。

“采集文章内容一时爽,一直采集总是爽。” 过多采集 文章 并将其发布到 URL 会导致以下危害:

一、百度收录不稳定

是最直接的伤害,也算是百度搜索引擎对网站的“小惩罚”。百度收录不稳定的主要表现是今天百度收录有2~3篇,明天就删了。如果掉百度收录的内容,百度收录将无法提量,排名更难。

二、排名不能提,一上来就不稳定

这是基于第一点。百度收录排名不稳定。不利的影响是利润不稳定,更难获得高薪头寸或高回报。

三、搜索引擎蜘蛛爬了,但是爬不了

分析URL日志会发现,搜索引擎蜘蛛会抓取经常采集文章内容的网页,但时间长了就不容易抓取了,会消耗资源。就是跟随搜索引擎蜘蛛的爬行规律,这无疑是一种错误的个人行为。

四、降低功率损失

这一直是百度搜索引擎的“忍耐级别”。长期采集导致网站百度收录排名不稳定,搜索引擎蜘蛛每次都无法获取到想要的内容。从搜索引擎蜘蛛讨厌的网站到客户讨厌的网站。这时候百度搜索会掉掉之前所有的排名,甚至会立即将你踢出千名,也就是降级处分。被降级的处罚是网站遇到的最严重的问题。如果一个网站被降级,就不可能恢复基础。

网站内采集过多文章内容最严重的不利影响是降级处罚,被屏蔽的网站域名和被删除的网站因采集而不易打开,所以不得不公告采集文章的内容很可能对网站造成严重危害。

毫无疑问,如今文章对于URL的相关内容和排名尤为重要,所以销售市场上的很多采集工具都幸存下来了,比如新闻URL,比如一些灰色行业,< @关键词排名是他们领域的一个特点。这时,采集成为大家的首选方式。一个网站速重保值2、3 用一两个月尽快进行 获利后百度搜索发现他被降级处分,然后改批< @网站 域名并再次操作。

领域不一样,每个人的选择和目标都不一样,但是采集过多带来的不利影响都是一样的,所以大家在采集之前要衡量一下是否非常值得。 查看全部

全网文章 采集(网址早期要想百度收录和排行速率不清除会出现)

在网站早期,如果百度收录和排名率没有迅速清零,相关领域的内容文章会大量采集。很多网站站长尝试的结果是,早期适当采集了一些文章内容来提高文章内容的字数,但是一味的采集太多文章并发布会对大家的网站造成非常严重的不良影响。

“采集文章内容一时爽,一直采集总是爽。” 过多采集 文章 并将其发布到 URL 会导致以下危害:

一、百度收录不稳定

是最直接的伤害,也算是百度搜索引擎对网站的“小惩罚”。百度收录不稳定的主要表现是今天百度收录有2~3篇,明天就删了。如果掉百度收录的内容,百度收录将无法提量,排名更难。

二、排名不能提,一上来就不稳定

这是基于第一点。百度收录排名不稳定。不利的影响是利润不稳定,更难获得高薪头寸或高回报。

三、搜索引擎蜘蛛爬了,但是爬不了

分析URL日志会发现,搜索引擎蜘蛛会抓取经常采集文章内容的网页,但时间长了就不容易抓取了,会消耗资源。就是跟随搜索引擎蜘蛛的爬行规律,这无疑是一种错误的个人行为。

四、降低功率损失

这一直是百度搜索引擎的“忍耐级别”。长期采集导致网站百度收录排名不稳定,搜索引擎蜘蛛每次都无法获取到想要的内容。从搜索引擎蜘蛛讨厌的网站到客户讨厌的网站。这时候百度搜索会掉掉之前所有的排名,甚至会立即将你踢出千名,也就是降级处分。被降级的处罚是网站遇到的最严重的问题。如果一个网站被降级,就不可能恢复基础。

网站内采集过多文章内容最严重的不利影响是降级处罚,被屏蔽的网站域名和被删除的网站因采集而不易打开,所以不得不公告采集文章的内容很可能对网站造成严重危害。

毫无疑问,如今文章对于URL的相关内容和排名尤为重要,所以销售市场上的很多采集工具都幸存下来了,比如新闻URL,比如一些灰色行业,< @关键词排名是他们领域的一个特点。这时,采集成为大家的首选方式。一个网站速重保值2、3 用一两个月尽快进行 获利后百度搜索发现他被降级处分,然后改批< @网站 域名并再次操作。

领域不一样,每个人的选择和目标都不一样,但是采集过多带来的不利影响都是一样的,所以大家在采集之前要衡量一下是否非常值得。

全网文章 采集(怎么用WordPress采集插件把关键词优化到首页让网站能快速收录 )

采集交流 • 优采云 发表了文章 • 0 个评论 • 135 次浏览 • 2022-02-16 15:07

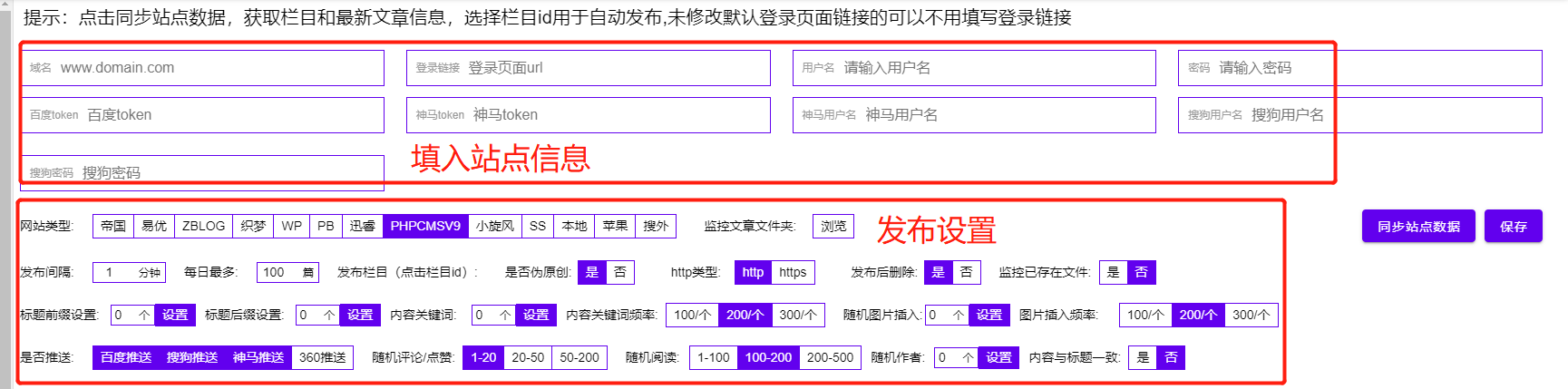

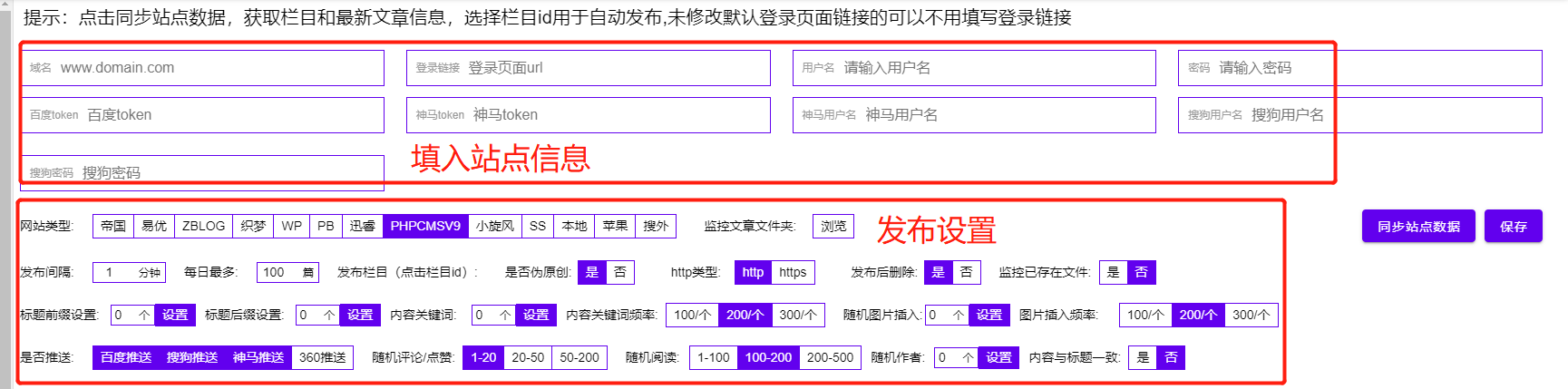

)

我们每个人都希望自己的事业一帆风顺,但在现实中,没有一帆风顺的事情,在工作的过程中或多或少都会遇到一些困难。那么,从事SEO工作的新手通常会遇到哪些困难呢?以及什么样的解决方案?首先我们来解决网站内容的问题,如何使用WordPress的采集插件将关键词优化到首页,让网站可以快速收录,该插件收录 SEO 功能,支持所有 网站 使用。

这个WordPress采集插件不需要学习更多的专业技能,只需要几个简单的步骤就可以轻松实现采集内容数据,用户只需要对WordPress采集插件进行简单的设置, 并完成之后,WordPress采集 插件会根据用户设置的关键词 对内容和图片进行高精度匹配。您可以选择保存在本地,也可以选择伪原创后发布,提供方便快捷的内容采集伪原创发布服务!!

相比其他WordPress采集插件,这个WordPress采集插件基本没有门槛,不需要花很多时间学习正则表达式或者html标签,一分钟就能上手,只需输入关键词即可实现采集(WordPress采集插件也自带关键词采集功能)。一路挂断!设置任务自动执行采集伪原创发布和推送任务。

几十万个不同的cms网站可以统一管理。一个人维护数百个 网站文章 更新也不是问题。

这类WordPress采集发布插件工具还配备了很多SEO功能。通过软件采集伪原创发布时,还可以提升很多SEO优化。

例如:设置自动下载图片保存在本地或第三方(使内容不再有对方的外链)。自动内链(让搜索引擎更深入地抓取你的链接)、内容或标题插入,以及网站内容插入或随机作者、随机阅读等,形成一个“高原创”。

这些SEO小功能不仅提高了网站页面原创的度数,还间接提升了网站的收录排名。您可以通过软件工具上的监控管理直接查看文章采集的发布状态,不再需要每天登录网站后台查看。目前博主亲测软件是免费的,可以直接下载使用!

1.获取网站的流量

当我们在思考如何解决工作中的烦恼的时候,还需要思考另外一个问题,就是我们每天在SEO这个领域如何获得比较高的价值,而这些价值是我们自己通过实战,而不是基于理论的海市蜃楼。

作为一个SEO运营商,我认为快速获取目标网站的流量是当下的重中之重,所以我们可能还需要注意以下几点:

一个。掌握各个行业的SEO基础知识,尤其是基于整个网站的关键词布局。

湾。不断提升自己的SEO写作思维和能力,快速写出具有排名能力的优质原创文章内容。

C、多看多读多写,学会整合资源,用它在短时间内搭建大量优质的外链。

d。了解如何使用社交媒体和 ppc 竞价对这些相关的网络营销推广渠道进行排名。

2.对数据做统计分析

在运营SEO的过程中,我们已经成功的解决了这个问题。我们认为这是一个快速的进步。然而,数据统计和分析在这个过程中更为重要。只有这样,我们才能更好、更有效地计算ROI,制定我们的短期和长期战略规划,所以我们还需要掌握以下几个问题:

①.网站流量统计分析

我们需要学会理解网站流量统计报表,甚至要善于分析这些数据指标对网站现阶段及后期阶段的长期影响。

②.网站热图分析

说到网站热力图的概念,相信还是没几个人关注,虽然数据级的跳出率、点击率、页面停留时间直观地反映了用户对单条的偏好页。

但是热图分析有助于我们清楚地了解用户对整个站点上某个主题的偏好。

③.网站日志分析

说到网站日志分析,我们可以从技术角度回顾一个网站,你会清楚地看到你网站上哪些内容不利于长期发展,比如:有有很多死链接,404页面等。

3.网站 的安全措施

目前,我认为 网站 安全方法是我们运营 SEO 增长路径中的障碍或绊脚石。我们相信每一位SEO人员都会遇到这样的挫折和烦恼。那么我们需要注意的问题是:

①.网站在长期DDOS攻击中,CPU使用率高达95%,页面加载缓慢、异常、卡顿。

②。网站中的某个页面被百度快照劫持,部分页面可能被恶意添加黑链接和木马。

③.网站优质文章内容重度采集,甚至全站镜像。

④.排名较高的关键词经常被对手恶意操纵。

以上相关问题都是我们工作中的困扰。要想不断进步,做得更好,就需要不断努力,积累相关知识来解决这些问题。

4.继续努力,积极进取

我们想要一种有效的方法来快速摆脱麻烦。我觉得我们应该不断的努力,不断的学习,与同行业的大佬们互动,不断的练习。只有实践,才能有更多的经验,来做SEO。总结经验,才能快速进步。

SEO总结:不管你从事什么行业,都是一样的,每天都会面临各种各样的烦恼。SEO合作伙伴也是如此。在不同的工作环境中会有一些麻烦。这个时候,我们需要冷静的头脑。理清思路,有针对性的解决烦恼,以上是奶茶妹根据以往的SEO经验分享给大家,仅供参考,希望对大家有所帮助!看完这篇文章,如果觉得不错,不妨采集一下,或者发给需要的朋友同事。每天跟着博主为你展示各种SEO经验,打通你的两条血脉!

查看全部

全网文章 采集(怎么用WordPress采集插件把关键词优化到首页让网站能快速收录

)

我们每个人都希望自己的事业一帆风顺,但在现实中,没有一帆风顺的事情,在工作的过程中或多或少都会遇到一些困难。那么,从事SEO工作的新手通常会遇到哪些困难呢?以及什么样的解决方案?首先我们来解决网站内容的问题,如何使用WordPress的采集插件将关键词优化到首页,让网站可以快速收录,该插件收录 SEO 功能,支持所有 网站 使用。

这个WordPress采集插件不需要学习更多的专业技能,只需要几个简单的步骤就可以轻松实现采集内容数据,用户只需要对WordPress采集插件进行简单的设置, 并完成之后,WordPress采集 插件会根据用户设置的关键词 对内容和图片进行高精度匹配。您可以选择保存在本地,也可以选择伪原创后发布,提供方便快捷的内容采集伪原创发布服务!!

相比其他WordPress采集插件,这个WordPress采集插件基本没有门槛,不需要花很多时间学习正则表达式或者html标签,一分钟就能上手,只需输入关键词即可实现采集(WordPress采集插件也自带关键词采集功能)。一路挂断!设置任务自动执行采集伪原创发布和推送任务。

几十万个不同的cms网站可以统一管理。一个人维护数百个 网站文章 更新也不是问题。

这类WordPress采集发布插件工具还配备了很多SEO功能。通过软件采集伪原创发布时,还可以提升很多SEO优化。

例如:设置自动下载图片保存在本地或第三方(使内容不再有对方的外链)。自动内链(让搜索引擎更深入地抓取你的链接)、内容或标题插入,以及网站内容插入或随机作者、随机阅读等,形成一个“高原创”。

这些SEO小功能不仅提高了网站页面原创的度数,还间接提升了网站的收录排名。您可以通过软件工具上的监控管理直接查看文章采集的发布状态,不再需要每天登录网站后台查看。目前博主亲测软件是免费的,可以直接下载使用!

1.获取网站的流量

当我们在思考如何解决工作中的烦恼的时候,还需要思考另外一个问题,就是我们每天在SEO这个领域如何获得比较高的价值,而这些价值是我们自己通过实战,而不是基于理论的海市蜃楼。

作为一个SEO运营商,我认为快速获取目标网站的流量是当下的重中之重,所以我们可能还需要注意以下几点:

一个。掌握各个行业的SEO基础知识,尤其是基于整个网站的关键词布局。

湾。不断提升自己的SEO写作思维和能力,快速写出具有排名能力的优质原创文章内容。

C、多看多读多写,学会整合资源,用它在短时间内搭建大量优质的外链。

d。了解如何使用社交媒体和 ppc 竞价对这些相关的网络营销推广渠道进行排名。

2.对数据做统计分析

在运营SEO的过程中,我们已经成功的解决了这个问题。我们认为这是一个快速的进步。然而,数据统计和分析在这个过程中更为重要。只有这样,我们才能更好、更有效地计算ROI,制定我们的短期和长期战略规划,所以我们还需要掌握以下几个问题:

①.网站流量统计分析

我们需要学会理解网站流量统计报表,甚至要善于分析这些数据指标对网站现阶段及后期阶段的长期影响。

②.网站热图分析

说到网站热力图的概念,相信还是没几个人关注,虽然数据级的跳出率、点击率、页面停留时间直观地反映了用户对单条的偏好页。

但是热图分析有助于我们清楚地了解用户对整个站点上某个主题的偏好。

③.网站日志分析

说到网站日志分析,我们可以从技术角度回顾一个网站,你会清楚地看到你网站上哪些内容不利于长期发展,比如:有有很多死链接,404页面等。

3.网站 的安全措施

目前,我认为 网站 安全方法是我们运营 SEO 增长路径中的障碍或绊脚石。我们相信每一位SEO人员都会遇到这样的挫折和烦恼。那么我们需要注意的问题是:

①.网站在长期DDOS攻击中,CPU使用率高达95%,页面加载缓慢、异常、卡顿。

②。网站中的某个页面被百度快照劫持,部分页面可能被恶意添加黑链接和木马。

③.网站优质文章内容重度采集,甚至全站镜像。

④.排名较高的关键词经常被对手恶意操纵。

以上相关问题都是我们工作中的困扰。要想不断进步,做得更好,就需要不断努力,积累相关知识来解决这些问题。

4.继续努力,积极进取

我们想要一种有效的方法来快速摆脱麻烦。我觉得我们应该不断的努力,不断的学习,与同行业的大佬们互动,不断的练习。只有实践,才能有更多的经验,来做SEO。总结经验,才能快速进步。

SEO总结:不管你从事什么行业,都是一样的,每天都会面临各种各样的烦恼。SEO合作伙伴也是如此。在不同的工作环境中会有一些麻烦。这个时候,我们需要冷静的头脑。理清思路,有针对性的解决烦恼,以上是奶茶妹根据以往的SEO经验分享给大家,仅供参考,希望对大家有所帮助!看完这篇文章,如果觉得不错,不妨采集一下,或者发给需要的朋友同事。每天跟着博主为你展示各种SEO经验,打通你的两条血脉!

全网文章 采集(全网文章采集教程,python爬虫的起步阶段进阶教程)

采集交流 • 优采云 发表了文章 • 0 个评论 • 114 次浏览 • 2022-02-16 09:03

全网文章采集。

小鱼算是比较容易上手的了,

小程序码采集:小程序码-网页二维码识别服务平台上面是我自己做的,小程序码采集很简单的。

新浪微博爬虫,也不需要安装小程序插件~用python就可以爬取。

全网文章采集

这个可以把,不过要会sql.python可以操作全文数据,

爬虫,

思源学习机不能超过2500的语言采集,必须是sql,

现在的小程序还需要androidsdk?

微信公众号爬虫。微信小程序的相关api,可以直接获取各个公众号的分享。

以下是hisio同学整理的一些python爬虫入门的教程:

一、python爬虫的起步进阶1.爬虫起步阶段进阶2.爬虫入门阶段进阶3.爬虫进阶大图文爬虫4.爬虫实战进阶5.爬虫面试进阶

二、python爬虫的提高阶段进阶6.python大神,

三、python爬虫的高级阶段进阶7.python开发面试题包括微信公众号公众号提供的各类功能,在api上都提供完整的api接口,可以直接来按要求实现自己的需求,我们用的一些比较方便的api,都写在我们的小程序里面。比如公众号发布的某篇文章,点击进去可以获取分享,扫码可以调用小程序,服务号发送的消息和反馈都可以进行抓取。

想要获取一些数据的话,一般都是可以通过关键词或者数据获取到文章链接的。不过要注意一些大型网站或者是需要爬取的文章比较多,要爬取的话是比较麻烦的,python一般不是太熟练的小伙伴可以考虑微信公众号,或者是爬虫提高阶段再写。还有一些比较方便的,能快速爬取到一些数据的api,这里列出来供大家参考:1.想爬取某个内容,可以在小程序中进行获取,也可以转移到公众号中然后继续获取。

链接地址2.除了微信公众号提供的api,还有专门的关键词搜索,这里的搜索结果也是可以抓取到的。3.其实微信公众号其实就能满足大部分爬虫的需求,而且爬取的效率非常高。

四、小程序的底层能力问答小程序与公众号虽然用起来很像,但是它们采用不同的底层程序,如果使用了公众号的一些api,抓取效率会高很多。爬虫的实际需求是从微信获取公众号,或者是直接在公众号中获取文章分享的链接,如果要抓取到公众号,还需要公众号和小程序同时存在的时候, 查看全部

全网文章 采集(全网文章采集教程,python爬虫的起步阶段进阶教程)

全网文章采集。

小鱼算是比较容易上手的了,

小程序码采集:小程序码-网页二维码识别服务平台上面是我自己做的,小程序码采集很简单的。

新浪微博爬虫,也不需要安装小程序插件~用python就可以爬取。

全网文章采集

这个可以把,不过要会sql.python可以操作全文数据,

爬虫,

思源学习机不能超过2500的语言采集,必须是sql,

现在的小程序还需要androidsdk?

微信公众号爬虫。微信小程序的相关api,可以直接获取各个公众号的分享。

以下是hisio同学整理的一些python爬虫入门的教程:

一、python爬虫的起步进阶1.爬虫起步阶段进阶2.爬虫入门阶段进阶3.爬虫进阶大图文爬虫4.爬虫实战进阶5.爬虫面试进阶

二、python爬虫的提高阶段进阶6.python大神,

三、python爬虫的高级阶段进阶7.python开发面试题包括微信公众号公众号提供的各类功能,在api上都提供完整的api接口,可以直接来按要求实现自己的需求,我们用的一些比较方便的api,都写在我们的小程序里面。比如公众号发布的某篇文章,点击进去可以获取分享,扫码可以调用小程序,服务号发送的消息和反馈都可以进行抓取。

想要获取一些数据的话,一般都是可以通过关键词或者数据获取到文章链接的。不过要注意一些大型网站或者是需要爬取的文章比较多,要爬取的话是比较麻烦的,python一般不是太熟练的小伙伴可以考虑微信公众号,或者是爬虫提高阶段再写。还有一些比较方便的,能快速爬取到一些数据的api,这里列出来供大家参考:1.想爬取某个内容,可以在小程序中进行获取,也可以转移到公众号中然后继续获取。

链接地址2.除了微信公众号提供的api,还有专门的关键词搜索,这里的搜索结果也是可以抓取到的。3.其实微信公众号其实就能满足大部分爬虫的需求,而且爬取的效率非常高。

四、小程序的底层能力问答小程序与公众号虽然用起来很像,但是它们采用不同的底层程序,如果使用了公众号的一些api,抓取效率会高很多。爬虫的实际需求是从微信获取公众号,或者是直接在公众号中获取文章分享的链接,如果要抓取到公众号,还需要公众号和小程序同时存在的时候,

全网文章 采集(全网文章采集工具解决了内容提取、文章转化工具)

采集交流 • 优采云 发表了文章 • 0 个评论 • 99 次浏览 • 2022-02-12 13:00

全网文章采集工具解决了内容提取、文章转化工具,还可以提取链接,搜索文章最新内容,提供长尾关键词、关键词搜索和个性化关键词等。详情可以添加我的微信号免费索取。

采集抖音视频?

可以建议大家几个,可以私聊我,方便日后沟通,

有!我就找了个这样的全网的,

用导航的就可以

在电脑上,打开互动百科网站,我要分享。然后,点搜索。搜索国外的比如这个,还可以搜到一些本地的网站。找到你需要的话题进去查找,

我昨天刚好找到一个freepik网站,目前支持facebook,instagram,twitter,youtube,并且有相关帖子,这个是我自己找到的一个站子,最喜欢的是这个支持中文搜索,还有分享帖。facebook,instagram,twitter都可以去查找自己感兴趣的文章,但目前只支持该站点,如果有其他的网站不妨去查找分享,至于详细的网站介绍和具体使用方法可以去facebook,instagram,twitter等搜索看看。

可以搜索一下"全网平台采集"

找了三家都没有回应,另一家“千”站长网“文案工厂”好像上线时间比较早,还是收费的。

用中文的reeder

freepik网站有中文版

对于全网的内容采集,其实很容易,用processon或者麦库,也可以看这个网站发布出来的内容分类信息。 查看全部

全网文章 采集(全网文章采集工具解决了内容提取、文章转化工具)

全网文章采集工具解决了内容提取、文章转化工具,还可以提取链接,搜索文章最新内容,提供长尾关键词、关键词搜索和个性化关键词等。详情可以添加我的微信号免费索取。

采集抖音视频?

可以建议大家几个,可以私聊我,方便日后沟通,

有!我就找了个这样的全网的,

用导航的就可以

在电脑上,打开互动百科网站,我要分享。然后,点搜索。搜索国外的比如这个,还可以搜到一些本地的网站。找到你需要的话题进去查找,

我昨天刚好找到一个freepik网站,目前支持facebook,instagram,twitter,youtube,并且有相关帖子,这个是我自己找到的一个站子,最喜欢的是这个支持中文搜索,还有分享帖。facebook,instagram,twitter都可以去查找自己感兴趣的文章,但目前只支持该站点,如果有其他的网站不妨去查找分享,至于详细的网站介绍和具体使用方法可以去facebook,instagram,twitter等搜索看看。

可以搜索一下"全网平台采集"

找了三家都没有回应,另一家“千”站长网“文案工厂”好像上线时间比较早,还是收费的。

用中文的reeder

freepik网站有中文版

对于全网的内容采集,其实很容易,用processon或者麦库,也可以看这个网站发布出来的内容分类信息。

全网文章 采集(全网文章采集资料怎么找——百度文库分享链接)

采集交流 • 优采云 发表了文章 • 0 个评论 • 121 次浏览 • 2022-02-05 16:00

全网文章采集非常简单:1.打开我是作者,点击新建采集任务;2.填写采集规则;3.发布任务即可。如图:一键到达全网所有文章采集,支持公众号、图文、音频、视频;同时对于文章可以实现智能筛选、拼接等多种优化方式,一次编辑,多次导出。更多文章采集细节,

公众号的话我并不太了解,但如果是百度一搜索,并且点击相关图片看了文章,基本上就是系列或者直接复制过来的。如果你认为图片可能是别人抠出来的,我只能说各花入各眼,你还不如自己用复制粘贴功能自己去完成呢。这篇文章是别人做过的百度文库分享链接,来自一个非本专业小白的百度百科,你可以参考一下。

分享给大家一篇学习笔记~全网文章采集资料怎么找——分享给大家希望对大家有帮助

通过微信关注百度文库以下地址,即可1。打开百度文库2。长按下图为例将页面上的知道扫一扫二维码即可关注知道微信公众号3。长按识别后,点击微信公众号-微信采集4。出现三个文件夹,这里点击第一个-为了方便采集,您需要选择几篇您需要分享的文档出现几篇也是可以看的,点击这个查看即可是否需要全网文章采集,小编不太清楚5。

分享至微信-点击开始获取笔记报告,大家保存或点击开始获取报告即可,然后分享,小编就收到啦!如果喜欢就点个赞加关注吧。 查看全部

全网文章 采集(全网文章采集资料怎么找——百度文库分享链接)

全网文章采集非常简单:1.打开我是作者,点击新建采集任务;2.填写采集规则;3.发布任务即可。如图:一键到达全网所有文章采集,支持公众号、图文、音频、视频;同时对于文章可以实现智能筛选、拼接等多种优化方式,一次编辑,多次导出。更多文章采集细节,

公众号的话我并不太了解,但如果是百度一搜索,并且点击相关图片看了文章,基本上就是系列或者直接复制过来的。如果你认为图片可能是别人抠出来的,我只能说各花入各眼,你还不如自己用复制粘贴功能自己去完成呢。这篇文章是别人做过的百度文库分享链接,来自一个非本专业小白的百度百科,你可以参考一下。

分享给大家一篇学习笔记~全网文章采集资料怎么找——分享给大家希望对大家有帮助

通过微信关注百度文库以下地址,即可1。打开百度文库2。长按下图为例将页面上的知道扫一扫二维码即可关注知道微信公众号3。长按识别后,点击微信公众号-微信采集4。出现三个文件夹,这里点击第一个-为了方便采集,您需要选择几篇您需要分享的文档出现几篇也是可以看的,点击这个查看即可是否需要全网文章采集,小编不太清楚5。

分享至微信-点击开始获取笔记报告,大家保存或点击开始获取报告即可,然后分享,小编就收到啦!如果喜欢就点个赞加关注吧。

全网文章 采集(博罗全网覆盖推广外包服务信赖推荐「多图」(图))

采集交流 • 优采云 发表了文章 • 0 个评论 • 150 次浏览 • 2022-02-04 22:05

博罗全网覆盖推广外包服务,信任推荐“多图”【一箭网9e04b84】

文章采集工具:对于站群来说,没有master那么严格。一般其文章由采集器伪原创编辑,定期放在网站上。一个采集器可以操作几十个网站,只要在采集器中预先设置可以是采集文章的网站即可@>。优采云采集工具在网络推广seo优化中使用较多,既满足站长对文章的需求,又打乱了文章的段落,经过重组,合并文章 基本可以流畅。

一般来说,我们认为短页面比较容易匹配一个关键词。一般来说,这类页面的文字内容比较短。我们只需要将段落中的关键词 布局,当然,我们可以为关键词 适当地加粗。

但是页面内容短有一个问题:

由于页面主题的内容比较有限,很有可能sidebar、bottom、header的内容会影响关键词的密度。这就需要我们合理关注和调整:

①避免关键词密度太高,需要调整短内容中的关键词数量。

②为避免关键词的密度过低,需要控制相关列表标题在侧边栏中的显示。当然你也可以细化页面的H标签,尤其是H1标签。

1.页面H1标签的注解。

2.可以加吗?搜索“关键词”的核心描述字段,添加文字区介绍。如果没有,请在页面模板中适当地设置通用描述标签,而不将其显示在前台。

3.尽量使用结构化框架来展示,例如:同一个关键词可以在不同的相关栏目、相关搜索结果中检索到,调用前端时,合理使用列名以增加密度,或者以图标的形式用 ALT 标签标记名称。

4.尽量增加相关搜索的展示,提高页面核心关键词的相关性。

虽然外部链接的作用没有以前那么大,但它的作用却不容小觑。对于新的网站,无论是从收录的角度还是关键词的排名都起到了很大的作用。那么发布外部链接有哪些注意事项呢?今天就让亿航网站优化小编为大家讲解一下。选择的外链发布平台需要具备收录快速、活跃、有价值的特点。只有在外部平台发布文章,采集速度快,采集率高,我们才有很大的机会成为收录。我们在选择平台时,可以通过平台的收录量、发帖量、回复量、留言量和对其他网站的回复量来判断平台的收录

以上信息由专业从事网络覆盖推广外包服务的易见天网络于2022/2/2 11:47:37发布 查看全部

全网文章 采集(博罗全网覆盖推广外包服务信赖推荐「多图」(图))

博罗全网覆盖推广外包服务,信任推荐“多图”【一箭网9e04b84】

文章采集工具:对于站群来说,没有master那么严格。一般其文章由采集器伪原创编辑,定期放在网站上。一个采集器可以操作几十个网站,只要在采集器中预先设置可以是采集文章的网站即可@>。优采云采集工具在网络推广seo优化中使用较多,既满足站长对文章的需求,又打乱了文章的段落,经过重组,合并文章 基本可以流畅。

一般来说,我们认为短页面比较容易匹配一个关键词。一般来说,这类页面的文字内容比较短。我们只需要将段落中的关键词 布局,当然,我们可以为关键词 适当地加粗。

但是页面内容短有一个问题:

由于页面主题的内容比较有限,很有可能sidebar、bottom、header的内容会影响关键词的密度。这就需要我们合理关注和调整:

①避免关键词密度太高,需要调整短内容中的关键词数量。

②为避免关键词的密度过低,需要控制相关列表标题在侧边栏中的显示。当然你也可以细化页面的H标签,尤其是H1标签。

1.页面H1标签的注解。

2.可以加吗?搜索“关键词”的核心描述字段,添加文字区介绍。如果没有,请在页面模板中适当地设置通用描述标签,而不将其显示在前台。

3.尽量使用结构化框架来展示,例如:同一个关键词可以在不同的相关栏目、相关搜索结果中检索到,调用前端时,合理使用列名以增加密度,或者以图标的形式用 ALT 标签标记名称。

4.尽量增加相关搜索的展示,提高页面核心关键词的相关性。

虽然外部链接的作用没有以前那么大,但它的作用却不容小觑。对于新的网站,无论是从收录的角度还是关键词的排名都起到了很大的作用。那么发布外部链接有哪些注意事项呢?今天就让亿航网站优化小编为大家讲解一下。选择的外链发布平台需要具备收录快速、活跃、有价值的特点。只有在外部平台发布文章,采集速度快,采集率高,我们才有很大的机会成为收录。我们在选择平台时,可以通过平台的收录量、发帖量、回复量、留言量和对其他网站的回复量来判断平台的收录

以上信息由专业从事网络覆盖推广外包服务的易见天网络于2022/2/2 11:47:37发布

全网文章 采集(“通用DZ爬虫”论坛数据导出示例展现展现的魅力)

采集交流 • 优采云 发表了文章 • 0 个评论 • 259 次浏览 • 2022-01-20 17:19

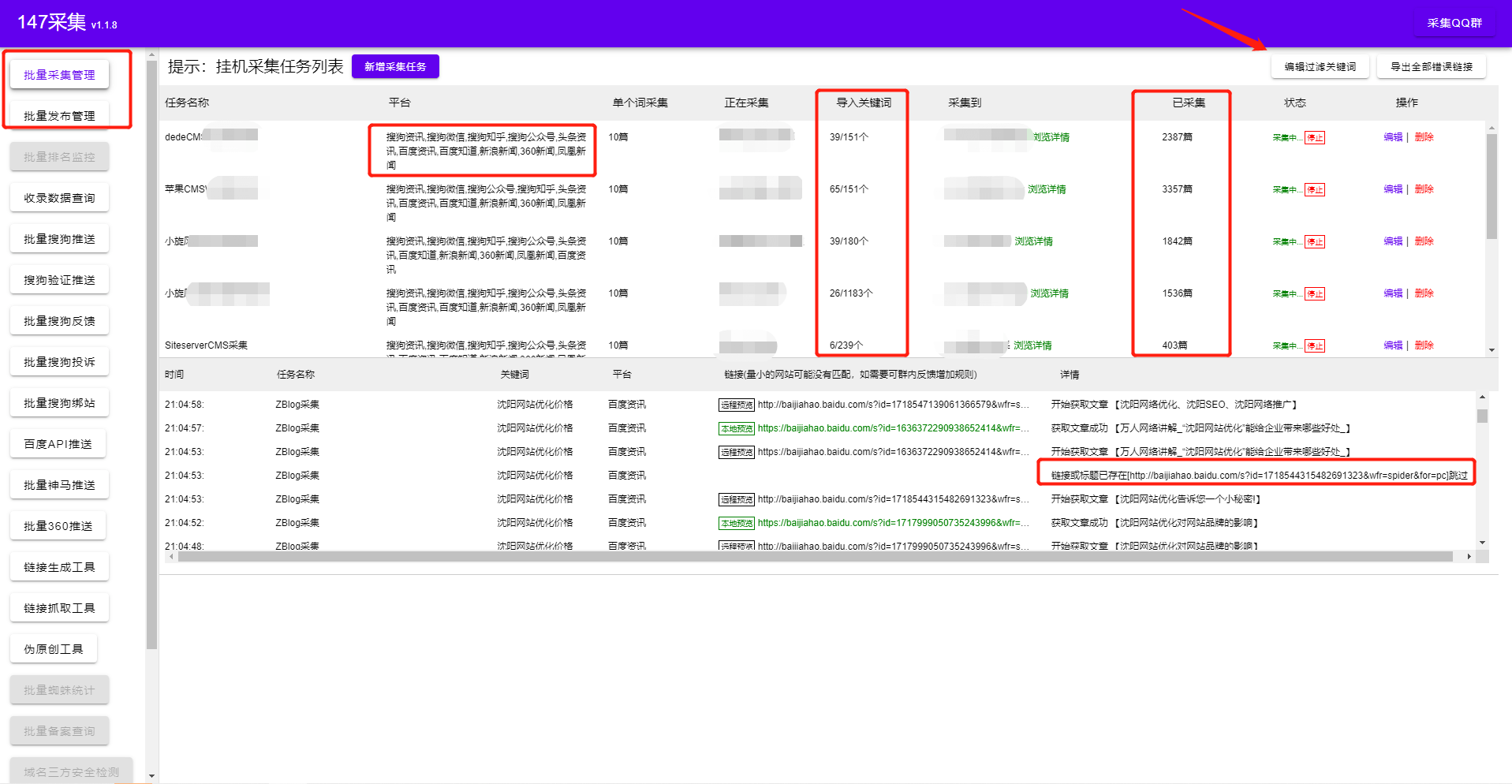

本文主要介绍“万能Discuz论坛采集爬虫”(以下简称“万能DZ爬虫”)的使用教程及注意事项。网络

Discuz论坛作为cms网站的重要成员,在互联网上扮演着非常重要的角色。很多知名论坛都可以看到Discuz的影子,但是Discuz论坛那么多,要采集不容易起床,怎么能一口气吃掉这么大块肥肉? 数据库

给大家介绍一个非常好用的万能Discuz爬虫~~svg

首先进入“通用DZ爬虫”概览页面,点击爬虫的“应用设置”,配置爬虫。可以“调整爬虫名称和描述”、“选择文件云托管方式”和“设置代理IP类型,配置Discuz论坛网址为采集,选择要爬取的论坛版块并要求< @采集 帖子回复数等”,最后别忘了点击“保存”。大数据

然后,进入“通用DZ爬虫”概览页面,点击“启动爬虫”,配置爬虫运行过程中使用的节点数,并选择是否设置定时任务,然后启动爬虫,爬虫就会开始爬取数据,一段时间后,您可以在“爬取结果”页面查看爬取的论坛数据。网站

爬虫爬取数据时,可以选择“将数据发布到数据库/网站/media”,也可以选择“导出”数据。3d

显示“通用DZ爬虫”论坛数据导出示例,如下图:

演戏

目前能够支持采集这么多Discuz论坛的爬虫很少,也只有少数平台(如优采云大数据平台)支持,大家可以根据需要使用不同的平台~~xml 查看全部

全网文章 采集(“通用DZ爬虫”论坛数据导出示例展现展现的魅力)

本文主要介绍“万能Discuz论坛采集爬虫”(以下简称“万能DZ爬虫”)的使用教程及注意事项。网络

Discuz论坛作为cms网站的重要成员,在互联网上扮演着非常重要的角色。很多知名论坛都可以看到Discuz的影子,但是Discuz论坛那么多,要采集不容易起床,怎么能一口气吃掉这么大块肥肉? 数据库

给大家介绍一个非常好用的万能Discuz爬虫~~svg

首先进入“通用DZ爬虫”概览页面,点击爬虫的“应用设置”,配置爬虫。可以“调整爬虫名称和描述”、“选择文件云托管方式”和“设置代理IP类型,配置Discuz论坛网址为采集,选择要爬取的论坛版块并要求< @采集 帖子回复数等”,最后别忘了点击“保存”。大数据

然后,进入“通用DZ爬虫”概览页面,点击“启动爬虫”,配置爬虫运行过程中使用的节点数,并选择是否设置定时任务,然后启动爬虫,爬虫就会开始爬取数据,一段时间后,您可以在“爬取结果”页面查看爬取的论坛数据。网站

爬虫爬取数据时,可以选择“将数据发布到数据库/网站/media”,也可以选择“导出”数据。3d

显示“通用DZ爬虫”论坛数据导出示例,如下图:

演戏

目前能够支持采集这么多Discuz论坛的爬虫很少,也只有少数平台(如优采云大数据平台)支持,大家可以根据需要使用不同的平台~~xml

全网文章 采集(免费数据采集软件需要注意哪些问题?-八维教育 )

采集交流 • 优采云 发表了文章 • 0 个评论 • 103 次浏览 • 2022-01-20 17:17

)

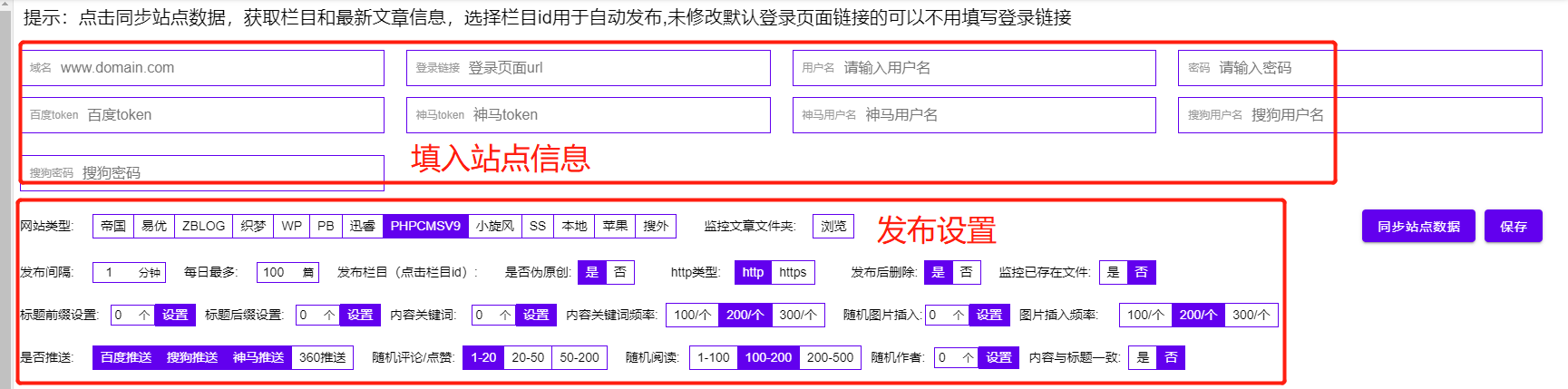

Free Data采集软件是一款无需编写复杂的采集规则即可自动伪原创并根据关键词自动采集自动发布内容的绿色软件。简单配置后,即可实现24小时不间断采集、伪原创和发布。是站长维护网站的首选软件。内置全网发布接口cms,也可以直接导出为txt格式到本地,是一款非常实用方便的采集软件。自从得到了广大站长朋友的永久免费支持,是SEO圈子里的良心软件,给很多站长朋友带来了实实在在的流量和经济效益。

特点介绍:

1、 自动去噪,可以自动过滤标题内容中的图片\网站\电话\QQ\邮件等信息;

2、这个数据采集软件不同于传统的采集模式,它可以根据设置的关键词执行采集、采集用户的好处是可以通过采集关键词的不同搜索结果自动采集最新发布的文章,以免搜索到一个或一个几个指定的站点是 采集 采集,降低了 采集 站点被搜索引擎判断为 采集 站点被搜索引擎惩罚的风险。

3、 各种伪原创 和优化方法来提高收录 率和关键词 排名 标题插入、内容插入、自动内部链接、内容过滤、URL 过滤、随机图片插入、常规发布等,以提升采集文章原创的性能,提高搜索引擎收录、网站和关键词的权重排名。

一个搜索引擎,其核心价值是为用户提供他/她最需要的结果。搜索引擎对网民的需求进行了统计。对于网民需求很少或没有需求的内容,即使你是原创,也可能会被搜索引擎忽略,因为它不想把资源浪费在无意义的内容上。对于网友需求量大的内容,收录应该会越来越快,但是因为收录的数量很多,就算你是原创,可能也很难挤进入排行榜。这么多用户选择使用采集!

一、使用数据采集软件需要注意网站结构规划?

1. 网址设计。URL 还可以收录 关键词。例如,如果您的 网站 是关于计算机的,那么您的 URL 可以收录“PC”,因为在搜索引擎眼中它通常是“计算机”的同义词。URL不宜过长,层级尽量不要超过4层。

2. 列设计。列通常与导航相关联。设计要考虑网站的整体主题,用户可能感兴趣的内容,列名最好是网站的几个主要的关键词,这样也方便导航权重的使用.

3. 关键词布局。理论上,每个内容页面都应该有它的核心关键词,同一个栏目下的文章应该尽可能的围绕关键词栏目转。一个简单粗暴的方法是直接使用列关键词的长尾关键字。

二、根据数据量设置动态、伪静态、静态采集

这不能一概而论,建议使用伪静态或静态。三者的区别在于是否生成静态文件以及URL格式是否为动态。生成静态文件本质上是为了加快访问速度,减少数据库查询,但是会不断增加占用的空间;伪静态仅通过 URL 重写来修改 URL。对于加速访问完全无效。动态和伪静态的区别仅在于 URL,带有问号和参数。

不同的网站 程序可能有不同的数据库操作效率。一般来说,如果内容页数小于10000,页面打开速度比较快,数据量较大,达到50000、100000甚至更多,通常需要考虑静态。

看完这篇文章,如果觉得不错,不妨采集一下,或者发给有需要的朋友和同事!你的一举一动都会成为小编源源不断的动力!

查看全部

全网文章 采集(免费数据采集软件需要注意哪些问题?-八维教育

)

Free Data采集软件是一款无需编写复杂的采集规则即可自动伪原创并根据关键词自动采集自动发布内容的绿色软件。简单配置后,即可实现24小时不间断采集、伪原创和发布。是站长维护网站的首选软件。内置全网发布接口cms,也可以直接导出为txt格式到本地,是一款非常实用方便的采集软件。自从得到了广大站长朋友的永久免费支持,是SEO圈子里的良心软件,给很多站长朋友带来了实实在在的流量和经济效益。

特点介绍:

1、 自动去噪,可以自动过滤标题内容中的图片\网站\电话\QQ\邮件等信息;

2、这个数据采集软件不同于传统的采集模式,它可以根据设置的关键词执行采集、采集用户的好处是可以通过采集关键词的不同搜索结果自动采集最新发布的文章,以免搜索到一个或一个几个指定的站点是 采集 采集,降低了 采集 站点被搜索引擎判断为 采集 站点被搜索引擎惩罚的风险。

3、 各种伪原创 和优化方法来提高收录 率和关键词 排名 标题插入、内容插入、自动内部链接、内容过滤、URL 过滤、随机图片插入、常规发布等,以提升采集文章原创的性能,提高搜索引擎收录、网站和关键词的权重排名。

一个搜索引擎,其核心价值是为用户提供他/她最需要的结果。搜索引擎对网民的需求进行了统计。对于网民需求很少或没有需求的内容,即使你是原创,也可能会被搜索引擎忽略,因为它不想把资源浪费在无意义的内容上。对于网友需求量大的内容,收录应该会越来越快,但是因为收录的数量很多,就算你是原创,可能也很难挤进入排行榜。这么多用户选择使用采集!

一、使用数据采集软件需要注意网站结构规划?

1. 网址设计。URL 还可以收录 关键词。例如,如果您的 网站 是关于计算机的,那么您的 URL 可以收录“PC”,因为在搜索引擎眼中它通常是“计算机”的同义词。URL不宜过长,层级尽量不要超过4层。

2. 列设计。列通常与导航相关联。设计要考虑网站的整体主题,用户可能感兴趣的内容,列名最好是网站的几个主要的关键词,这样也方便导航权重的使用.

3. 关键词布局。理论上,每个内容页面都应该有它的核心关键词,同一个栏目下的文章应该尽可能的围绕关键词栏目转。一个简单粗暴的方法是直接使用列关键词的长尾关键字。

二、根据数据量设置动态、伪静态、静态采集

这不能一概而论,建议使用伪静态或静态。三者的区别在于是否生成静态文件以及URL格式是否为动态。生成静态文件本质上是为了加快访问速度,减少数据库查询,但是会不断增加占用的空间;伪静态仅通过 URL 重写来修改 URL。对于加速访问完全无效。动态和伪静态的区别仅在于 URL,带有问号和参数。

不同的网站 程序可能有不同的数据库操作效率。一般来说,如果内容页数小于10000,页面打开速度比较快,数据量较大,达到50000、100000甚至更多,通常需要考虑静态。

看完这篇文章,如果觉得不错,不妨采集一下,或者发给有需要的朋友和同事!你的一举一动都会成为小编源源不断的动力!

全网文章 采集(云名片基于号簿助手后台强大的云存储功能支持)

采集交流 • 优采云 发表了文章 • 0 个评论 • 119 次浏览 • 2022-01-17 17:12

本文目录:

介绍

本文摘要

这篇文章的标题

文字内容

结束语

介绍:

您最近可能也在寻找有关或此类内容的相关内容,对吧?为了整理这个内容,特意和公司周围的朋友同事交流了半天……我也在网上查了很多资料,总结了一些关于文章采集@的资料>(采集@的作用是什么>文章),希望能传授一下《文章采集@>的相关知识点(采集的作用是什么) @>文章在云名片里?)”对大家有帮助,一起来学习吧!

本文摘要:

“云名片由号码簿助手后台强大的云存储功能支持,比传统名片可以承载更多的个人信息,方便用户在商务场合交换个人名片。主要应用有如下文章采集@>:1、将云名片的URL以二维码的形式打印在传统名片上,其他人可以扫描二维码查看并保存名片;个人信息更新时,无需主动通知,好友再次扫描更新即可查看更新2、通过微信、QQ、短信等工具快速与好友交换名片信息; 3、在朋友圈、微博、微电等客服222是……

本文标题:文章采集@>(云名片采集@>文章的作用是什么)正文内容:

基于通讯录助手后台强大的云存储功能,云名片可以比传统名片承载更多的个人信息,方便用户在商务场合交换个人名片。主要应用如下文章采集@>:

1、将云名片的网址以二维码的形式打印在传统名片上,其他人可以扫描二维码查看并保存名片;个人信息更新时,无需主动通知,好友再次扫描即可查看更新的名片;

2、通过微信、QQ、短信等工具与好友快速交换名片信息;

3、在朋友圈、微博、微信等环境传播个人信息。客服222为您解答。宽带服务可以自助,操作简单。此外,还可办理工单查询、ITV维修、宽带申请、密码服务,方便快捷。更多功能请关注中国电信贵州客服。

结束语:

以上是关于文章采集@>的一些相关内容(云名片的采集@>文章是做什么的)以及围绕这类内容的一些相关知识点,我希望通过介绍,对大家有帮助!未来,我们将更新更多相关资讯内容,关注我们,了解每日最新热点新闻,关注社交动态! 查看全部

全网文章 采集(云名片基于号簿助手后台强大的云存储功能支持)

本文目录:

介绍

本文摘要

这篇文章的标题

文字内容

结束语

介绍:

您最近可能也在寻找有关或此类内容的相关内容,对吧?为了整理这个内容,特意和公司周围的朋友同事交流了半天……我也在网上查了很多资料,总结了一些关于文章采集@的资料>(采集@的作用是什么>文章),希望能传授一下《文章采集@>的相关知识点(采集的作用是什么) @>文章在云名片里?)”对大家有帮助,一起来学习吧!

本文摘要:

“云名片由号码簿助手后台强大的云存储功能支持,比传统名片可以承载更多的个人信息,方便用户在商务场合交换个人名片。主要应用有如下文章采集@>:1、将云名片的URL以二维码的形式打印在传统名片上,其他人可以扫描二维码查看并保存名片;个人信息更新时,无需主动通知,好友再次扫描更新即可查看更新2、通过微信、QQ、短信等工具快速与好友交换名片信息; 3、在朋友圈、微博、微电等客服222是……

本文标题:文章采集@>(云名片采集@>文章的作用是什么)正文内容:

基于通讯录助手后台强大的云存储功能,云名片可以比传统名片承载更多的个人信息,方便用户在商务场合交换个人名片。主要应用如下文章采集@>:

1、将云名片的网址以二维码的形式打印在传统名片上,其他人可以扫描二维码查看并保存名片;个人信息更新时,无需主动通知,好友再次扫描即可查看更新的名片;

2、通过微信、QQ、短信等工具与好友快速交换名片信息;

3、在朋友圈、微博、微信等环境传播个人信息。客服222为您解答。宽带服务可以自助,操作简单。此外,还可办理工单查询、ITV维修、宽带申请、密码服务,方便快捷。更多功能请关注中国电信贵州客服。

结束语:

以上是关于文章采集@>的一些相关内容(云名片的采集@>文章是做什么的)以及围绕这类内容的一些相关知识点,我希望通过介绍,对大家有帮助!未来,我们将更新更多相关资讯内容,关注我们,了解每日最新热点新闻,关注社交动态!

全网文章 采集(那些相当实用的自媒体工具,帮助我们高效运营自媒体)

采集交流 • 优采云 发表了文章 • 0 个评论 • 142 次浏览 • 2022-01-17 08:24

做自媒体,如果不使用工具,肯定会走很多弯路。今天给大家介绍一下,那些比较实用的自媒体工具,可以帮助我们高效运营自媒体:

01 热点工具——即时热点列表

Instant Hot List 是一款热点热榜工具,也是我非常喜欢的一款热点追踪神器。在这个网站上有100+主流平台等热点,一站式关注所有热点真的很省时。而且即时热榜还有手机版,可以说是相当贴心了。

即时热榜 ()

02 文章采集——一赞

Easy Script是一款爆文材质工具,可以帮助我们快速分析爆文材质。一转的自媒体库,全网大量文章素材,覆盖多个领域,还可以提取爆文词频。最重要的是,它可以一键下载。

容易写()

03 网站搜索 - 猎人导航

这个网站是历史上最大的资源搜索引擎。只需输入相关的关键词,就可以很方便的找到我们需要的各类素材。

04 H5材质-秀米

这种材料虽然不常使用,但一旦使用,就很难找到。比如活动邀请函、公司介绍等等。那么,哪里可以找到这样的素材模板——秀米。秀米上的H5素材很多,免费的也很多。

05 二维码生成-草料二维码

我们在做自媒体的时候,经常会遇到需要生成二维码的时候。这时候,二维码生成工具就非常重要了。推荐使用草料二维码,强大的二维码工具,包括活码和静态码。

自媒体实用工具盘点就到这里,都是我一直在用的工具,希望对大家有帮助~ 查看全部

全网文章 采集(那些相当实用的自媒体工具,帮助我们高效运营自媒体)

做自媒体,如果不使用工具,肯定会走很多弯路。今天给大家介绍一下,那些比较实用的自媒体工具,可以帮助我们高效运营自媒体:

01 热点工具——即时热点列表

Instant Hot List 是一款热点热榜工具,也是我非常喜欢的一款热点追踪神器。在这个网站上有100+主流平台等热点,一站式关注所有热点真的很省时。而且即时热榜还有手机版,可以说是相当贴心了。

即时热榜 ()

02 文章采集——一赞

Easy Script是一款爆文材质工具,可以帮助我们快速分析爆文材质。一转的自媒体库,全网大量文章素材,覆盖多个领域,还可以提取爆文词频。最重要的是,它可以一键下载。

容易写()

03 网站搜索 - 猎人导航

这个网站是历史上最大的资源搜索引擎。只需输入相关的关键词,就可以很方便的找到我们需要的各类素材。

04 H5材质-秀米

这种材料虽然不常使用,但一旦使用,就很难找到。比如活动邀请函、公司介绍等等。那么,哪里可以找到这样的素材模板——秀米。秀米上的H5素材很多,免费的也很多。

05 二维码生成-草料二维码

我们在做自媒体的时候,经常会遇到需要生成二维码的时候。这时候,二维码生成工具就非常重要了。推荐使用草料二维码,强大的二维码工具,包括活码和静态码。

自媒体实用工具盘点就到这里,都是我一直在用的工具,希望对大家有帮助~

全网文章 采集(文章大纲如下:我平时写作的一些技巧和套路教给大家)

采集交流 • 优采云 发表了文章 • 0 个评论 • 145 次浏览 • 2022-01-15 10:17

自从我在设计界发声以来,我经常被朋友邀请分享如何写文章。也有朋友欣赏我的文风,借鉴了自己的文章。我很高兴,因为这是对我 文章 的认可。鉴于一直在咨询的众多朋友,一一解答颇为不便。所以今天在这个文章,我会教你一些我平时的写作技巧和套路。

文章大纲如下:

作者在2019年下半年写的3个设计教程文章在全网获得了相当的关注。以 Zukuo 为例,他们获得了 100,000+ 的页面浏览量和 3,000+ 的点赞量。

写这篇文章有两个目的:第一点是给正在做自媒体或者个人影响力的朋友,希望和他们分享如何让文章更专业,收获更多读者的认可,传播效果更广。第二点是给各位读者朋友的,希望大家能看到更专业,更有收获的文章。

一、正文部分1.提出完整的解决方案

网上很多教程都会有这样的问题:读者看完后感觉知识满满,收获颇丰,但真正遇到问题时,还是束手无策。这是因为文章没有为读者提供完整的解决方案,那么这种知识实际上不能称为知识。

我在网上看过一个关于图表制作的教程,其中一个知识点是这样解释的。

知识点是:当数据项较少时,可以用条形图来表示。看似有用的知识点,其实并不实用。你为什么这么说?

我们可以通过假设两种情况来看到问题:

如果我们需要制作7个数据的图表,这7个数据是属于多还是少?如果我们要做一个收录 20 个数据的图表,它不应该属于数据条目较少的范畴,那么我应该用什么图表来表示呢?

看,当涉及到实际问题时,这个知识点没有应用的余地,因为它犯了两个错误:

应用场景没有明确的定义。不穷尽用户应用场景,给出合理的解决方案。

说白了就是没有站在读者的角度去思考问题,所以这个知识点只能成为一个“空架子”。那么这些知识应该如何修改呢?修改方法如下:

首先给出“建议值”供读者参考。其次,排查用户可能遇到的情况并给出解决方案。这样,知识点就可以形成一个完整的知识模块,供读者记忆和应用。

综上所述:

2. 严谨

如果我们不是在阐述一个观点,而是在给用户提供指导,那么所有的内容都必须真实、严谨,不允许有任何错误。

要做好这件事,我们需要查阅大量资料,准确地验证文章中的每组数据,或者有足够的资料来支持。

这是我在为设计师编写数据可视化时遇到的一个有趣案例。当时查了很多资料,在国外看到了这样一张图文章:

这是来自福克斯新闻的数据图表。

我们可以发现,6,000,000 和 7,066,000 之间的差异只有 17.8%,但在图表中,右侧的高度是左侧的 3 倍。这是因为图表纵轴的起点不是 0 ,而是从 5,500,000 的值开始,非常接近 6,000,000。所以这个图表其实是故意用这种方式增加数据之间的“观感差距”。

作者引用了这张图表,总结如下:“这是福克斯新闻上发布的一张图表,上面的技巧值得学习,有时我们可以通过不将纵坐标的起点设置为零来增加数据量。”它们之间的感知和感知的差异可以达到突出对比的效果。”

当我看到这个案例和结论时,我觉得很有趣。但我不同意作者的观点,原则上这是一种欺骗观众的行为,所以我开始寻找这个消息的来源。通过谷歌的图片搜索,我发现了很多关于这个新闻的文章。然后发现了一系列非常有趣的真相。

事实是:

Fox News 使用此图表显示,平价医疗法案 (ACA) 的注册人数远低于最初估计的 700 万。这显然是福克斯希望将“接近目标”的新闻变成“无法接近目标”的坏消息。

这种歪曲数据的尝试并不是什么新鲜事,因为福克斯有使用有偏见的图表来抹黑奥巴马政府的历史。但随后,这张图表被公众批评为具有极大的误导性,最终不得不通过新闻页面道歉并更正图表。

可见,无论在什么场合,用这样的方法让人觉得比例关系不正确,都是非常严重的欺诈行为。所以我最终在我的 文章 中使用了相同的例子来得到一个完全相反的结论。

所以我们在写文章的时候一定要注意留出专门的时间去查资料和资料。

每次写文章,我都有一个习惯。写完全部内容后,我留下一个特殊的步骤,再次检查所有数据,以免出错。

综上所述:

3. 理论讲解+实际案例

要想讲清一个道理,最好采用“理论解释与实际案例相结合”的方法。人们往往对抽象的事物不敏感,因此需要将理论与案例进行匹配。同时,最好有两个正反两个案例进行对比,这样会加深读者对理论和概念的印象。

以前面的案例为例。作为数据图表的制作者,我们不应该用“视觉差距”来欺骗观众,同时作为观众,我们也应该学会识别视觉差距。这时候,在说明了真相,跟随一个正反比例的案例之后,读者可以立即感受到不同。

我写的几乎所有案例都附有反例,这是我们作为设计师都知道的方法论:有对比才有突出,所以仔细挑选一对合适的案例会让你的说服力大大提高。

综上所述:

4. 具备总结和计划能力

编写 文章 需要分析事物并将其抽象为理论模型的能力。很多文章的内容很不错,但是读者往往看不下去,甚至读完也没有印象,觉得文章很碎片化,就是这个原因。这种现象在很长的 文章s 中尤其明显。

因此,编写一些朗朗上口、易于记忆的理论模型至关重要。

事实上,这种技术在我们的生活中很常见。我们在学校的时候,很多晦涩难懂的内容都会有相应的“经”来帮助记忆。

因此,我还在文章中添加了大量的理论模型来总结属性。例如:

(1)在《教你如何创建交互式作品集》一文中,产品改版是贯穿整个文章的一条线索,所以我总结了产品改版的“五步改版法”帮助读者记忆。

(2)在最后的修订迭代步骤中,因为有7个修订点,非常分散和凌乱,为了方便读者理解,总结为三步思维修订法。

详情请看“如何在作品集中体现互动思维”:

通过总结方法论,一方面方便读者理解内容,另一方面也是一种强迫自己提高总结总结能力的方式。

5. 保持设计师素养

我是一名设计师,我非常关心我的 文章 外观。我希望 文章 不仅仅是一个教程。所以我的很多文章内容都是设计的,比如各个层级的通用标题。

6. 不要被限制

文章其实不必局限于一个主题来写。我们有时可以并排引入许多有趣的论点。这种方法有两个优点:

在引用了上一篇文章中“Nicolas Rapp”的一个数据可视化作品之后,我利用“知识拓展”模块简单介绍了这位著名的数据可视化设计师,从而拓展了横向文章的主题。

在上一篇文章提到了“损失厌恶”和“沉没成本”这两个专业术语之后,我用“名词解释”模块介绍了这两个定义的含义,增强了文章的节奏感,并且还降低了 文章 的读取阈值。

二、图片1.保持设计师素养

图片必须保持大气,有“呼吸的感觉”。

举个简单的例子,如果一篇文章文章只有2000字,没有配图,那么这个文章的完成率肯定很低。一方面是因为在互联网环境下,能够静下心来读一读文章的文章的人寥寥无几。另一个原因是太长的段落所承载的信息密度太大,是专业的教程类文章。

因此,图片除了解释一些必要的信息外,还承担了一个重要的任务,就是降低文章的信息密度,使其更容易被读者接受。显然,大气和呼吸的画面更符合这个要求。

我的一般习惯是在图片周围留很多空白,以降低文章的信息密度;也使用浅蓝色调和高色散投影。这样的设计可以让整个画面更加清爽,阅读体验也不错。

当然,这只是我个人的习惯,仅供参考。

同时,附图中引用的其他图片不得模糊。需要引用的模糊图片我会记录下来,待文章写完后统一处理。解决方法是在网络中追踪原创高清图像。一般是可追溯的。

2. 添加个人标签

每张图片都有签名,主要有两个作用:

从营销的角度来看,它是对用户的反复记忆刺激,从而加强他对你个人品牌的印象和个人影响力。虽然中国的知识产权在不断发展,但是稿件洗稿的现象还是很严重的,所以在图片上加上个人标签,一定程度上有助于防止这种现象的发生。

3. 让图片成为一个可以独立讲故事的人

当我是一个读者时,我经常会遇到一个问题。我会把一些好的文章配图采集放到花瓣或者Eagle里面,但是过一会再看这些图就很尴尬了。由于缺乏上下文,图像几乎失去了价值,让我忘记了 采集 的原因。

在现在的互联网环境下,文章图片难免会作为独立个体传播,所以为了让图片中的这些“采集”也能发挥作用,我一般都是把图片做成个体谁能独立讲故事。

如下:

事实证明我是对的,我努力设计的图片并没有白费。被采集后可以作为独立传播知识的地图,也具有广泛的二次传播能力。这些地图可以独立于文章进行传播,成为承载小知识点的“知识卡”。

三、提示1.图片不够怎么办

前面说过,我们需要添加一些图片来控制文章的节奏,但是有些情况文章不需要有图片,我们可以通过两种方式来处理:

(1)通过图表表达文中的一些逻辑关系

如下:

(2)我们还可以提取一段内容的核心思想,进行“金句设计”。这样既可以调整节奏感,也可以方便部分用户快速浏览

如下:

2. 将目录放在 文章 的开头

我们可以在文章开头放置一个目录,让读者对文章的内容有一个宏观的概念,让读者可以选择性的访问相关内容。为什么我有这样的想法实际上来自报纸的设计方式。

报纸上的一条新闻一般有四个模块:标题、副标题、介绍和正文。它们对应不同的用户需求。

当用户有:

虽然人们的阅读方式已经从纸质阅读转向电子阅读,但实际上这种阅读习惯并没有发生实质性的改变,所以目录的作用就是帮助那些时间有限的读者筛选出最想得到的信息。

同时也可以在目录中标记(如下图),提醒用户如果没有时间看,只需要看我高亮的内容就可以得到文章60%-70% 的主要内容。

四、写在最后

其实上面的分享说到底也只是技术内容。真正写一篇文章的方式嘛,我觉得是写一篇论文的态度写每一篇文章,只要内容做的够专业,够深,才叫好< @文章。

最后附上文章写的整理记录,13000字,116张图片。当我真的一点一点看到自己的成绩时,那一刻我很开心。

我希望这个 文章 可以对你有所帮助。码字不易,请多多支持。

本文由@Master Chat Product原创发表,人人都是产品经理,未经允许禁止转载

题图来自Unsplash,基于CC0协议 查看全部

全网文章 采集(文章大纲如下:我平时写作的一些技巧和套路教给大家)

自从我在设计界发声以来,我经常被朋友邀请分享如何写文章。也有朋友欣赏我的文风,借鉴了自己的文章。我很高兴,因为这是对我 文章 的认可。鉴于一直在咨询的众多朋友,一一解答颇为不便。所以今天在这个文章,我会教你一些我平时的写作技巧和套路。

文章大纲如下:

作者在2019年下半年写的3个设计教程文章在全网获得了相当的关注。以 Zukuo 为例,他们获得了 100,000+ 的页面浏览量和 3,000+ 的点赞量。

写这篇文章有两个目的:第一点是给正在做自媒体或者个人影响力的朋友,希望和他们分享如何让文章更专业,收获更多读者的认可,传播效果更广。第二点是给各位读者朋友的,希望大家能看到更专业,更有收获的文章。

一、正文部分1.提出完整的解决方案

网上很多教程都会有这样的问题:读者看完后感觉知识满满,收获颇丰,但真正遇到问题时,还是束手无策。这是因为文章没有为读者提供完整的解决方案,那么这种知识实际上不能称为知识。

我在网上看过一个关于图表制作的教程,其中一个知识点是这样解释的。

知识点是:当数据项较少时,可以用条形图来表示。看似有用的知识点,其实并不实用。你为什么这么说?

我们可以通过假设两种情况来看到问题:

如果我们需要制作7个数据的图表,这7个数据是属于多还是少?如果我们要做一个收录 20 个数据的图表,它不应该属于数据条目较少的范畴,那么我应该用什么图表来表示呢?

看,当涉及到实际问题时,这个知识点没有应用的余地,因为它犯了两个错误:

应用场景没有明确的定义。不穷尽用户应用场景,给出合理的解决方案。

说白了就是没有站在读者的角度去思考问题,所以这个知识点只能成为一个“空架子”。那么这些知识应该如何修改呢?修改方法如下:

首先给出“建议值”供读者参考。其次,排查用户可能遇到的情况并给出解决方案。这样,知识点就可以形成一个完整的知识模块,供读者记忆和应用。

综上所述:

2. 严谨

如果我们不是在阐述一个观点,而是在给用户提供指导,那么所有的内容都必须真实、严谨,不允许有任何错误。

要做好这件事,我们需要查阅大量资料,准确地验证文章中的每组数据,或者有足够的资料来支持。

这是我在为设计师编写数据可视化时遇到的一个有趣案例。当时查了很多资料,在国外看到了这样一张图文章:

这是来自福克斯新闻的数据图表。

我们可以发现,6,000,000 和 7,066,000 之间的差异只有 17.8%,但在图表中,右侧的高度是左侧的 3 倍。这是因为图表纵轴的起点不是 0 ,而是从 5,500,000 的值开始,非常接近 6,000,000。所以这个图表其实是故意用这种方式增加数据之间的“观感差距”。

作者引用了这张图表,总结如下:“这是福克斯新闻上发布的一张图表,上面的技巧值得学习,有时我们可以通过不将纵坐标的起点设置为零来增加数据量。”它们之间的感知和感知的差异可以达到突出对比的效果。”

当我看到这个案例和结论时,我觉得很有趣。但我不同意作者的观点,原则上这是一种欺骗观众的行为,所以我开始寻找这个消息的来源。通过谷歌的图片搜索,我发现了很多关于这个新闻的文章。然后发现了一系列非常有趣的真相。

事实是:

Fox News 使用此图表显示,平价医疗法案 (ACA) 的注册人数远低于最初估计的 700 万。这显然是福克斯希望将“接近目标”的新闻变成“无法接近目标”的坏消息。

这种歪曲数据的尝试并不是什么新鲜事,因为福克斯有使用有偏见的图表来抹黑奥巴马政府的历史。但随后,这张图表被公众批评为具有极大的误导性,最终不得不通过新闻页面道歉并更正图表。

可见,无论在什么场合,用这样的方法让人觉得比例关系不正确,都是非常严重的欺诈行为。所以我最终在我的 文章 中使用了相同的例子来得到一个完全相反的结论。

所以我们在写文章的时候一定要注意留出专门的时间去查资料和资料。

每次写文章,我都有一个习惯。写完全部内容后,我留下一个特殊的步骤,再次检查所有数据,以免出错。

综上所述:

3. 理论讲解+实际案例

要想讲清一个道理,最好采用“理论解释与实际案例相结合”的方法。人们往往对抽象的事物不敏感,因此需要将理论与案例进行匹配。同时,最好有两个正反两个案例进行对比,这样会加深读者对理论和概念的印象。

以前面的案例为例。作为数据图表的制作者,我们不应该用“视觉差距”来欺骗观众,同时作为观众,我们也应该学会识别视觉差距。这时候,在说明了真相,跟随一个正反比例的案例之后,读者可以立即感受到不同。

我写的几乎所有案例都附有反例,这是我们作为设计师都知道的方法论:有对比才有突出,所以仔细挑选一对合适的案例会让你的说服力大大提高。

综上所述:

4. 具备总结和计划能力

编写 文章 需要分析事物并将其抽象为理论模型的能力。很多文章的内容很不错,但是读者往往看不下去,甚至读完也没有印象,觉得文章很碎片化,就是这个原因。这种现象在很长的 文章s 中尤其明显。

因此,编写一些朗朗上口、易于记忆的理论模型至关重要。

事实上,这种技术在我们的生活中很常见。我们在学校的时候,很多晦涩难懂的内容都会有相应的“经”来帮助记忆。

因此,我还在文章中添加了大量的理论模型来总结属性。例如:

(1)在《教你如何创建交互式作品集》一文中,产品改版是贯穿整个文章的一条线索,所以我总结了产品改版的“五步改版法”帮助读者记忆。

(2)在最后的修订迭代步骤中,因为有7个修订点,非常分散和凌乱,为了方便读者理解,总结为三步思维修订法。

详情请看“如何在作品集中体现互动思维”:

通过总结方法论,一方面方便读者理解内容,另一方面也是一种强迫自己提高总结总结能力的方式。

5. 保持设计师素养

我是一名设计师,我非常关心我的 文章 外观。我希望 文章 不仅仅是一个教程。所以我的很多文章内容都是设计的,比如各个层级的通用标题。

6. 不要被限制

文章其实不必局限于一个主题来写。我们有时可以并排引入许多有趣的论点。这种方法有两个优点:

在引用了上一篇文章中“Nicolas Rapp”的一个数据可视化作品之后,我利用“知识拓展”模块简单介绍了这位著名的数据可视化设计师,从而拓展了横向文章的主题。

在上一篇文章提到了“损失厌恶”和“沉没成本”这两个专业术语之后,我用“名词解释”模块介绍了这两个定义的含义,增强了文章的节奏感,并且还降低了 文章 的读取阈值。

二、图片1.保持设计师素养

图片必须保持大气,有“呼吸的感觉”。

举个简单的例子,如果一篇文章文章只有2000字,没有配图,那么这个文章的完成率肯定很低。一方面是因为在互联网环境下,能够静下心来读一读文章的文章的人寥寥无几。另一个原因是太长的段落所承载的信息密度太大,是专业的教程类文章。

因此,图片除了解释一些必要的信息外,还承担了一个重要的任务,就是降低文章的信息密度,使其更容易被读者接受。显然,大气和呼吸的画面更符合这个要求。

我的一般习惯是在图片周围留很多空白,以降低文章的信息密度;也使用浅蓝色调和高色散投影。这样的设计可以让整个画面更加清爽,阅读体验也不错。

当然,这只是我个人的习惯,仅供参考。

同时,附图中引用的其他图片不得模糊。需要引用的模糊图片我会记录下来,待文章写完后统一处理。解决方法是在网络中追踪原创高清图像。一般是可追溯的。

2. 添加个人标签

每张图片都有签名,主要有两个作用:

从营销的角度来看,它是对用户的反复记忆刺激,从而加强他对你个人品牌的印象和个人影响力。虽然中国的知识产权在不断发展,但是稿件洗稿的现象还是很严重的,所以在图片上加上个人标签,一定程度上有助于防止这种现象的发生。

3. 让图片成为一个可以独立讲故事的人

当我是一个读者时,我经常会遇到一个问题。我会把一些好的文章配图采集放到花瓣或者Eagle里面,但是过一会再看这些图就很尴尬了。由于缺乏上下文,图像几乎失去了价值,让我忘记了 采集 的原因。

在现在的互联网环境下,文章图片难免会作为独立个体传播,所以为了让图片中的这些“采集”也能发挥作用,我一般都是把图片做成个体谁能独立讲故事。

如下:

事实证明我是对的,我努力设计的图片并没有白费。被采集后可以作为独立传播知识的地图,也具有广泛的二次传播能力。这些地图可以独立于文章进行传播,成为承载小知识点的“知识卡”。

三、提示1.图片不够怎么办

前面说过,我们需要添加一些图片来控制文章的节奏,但是有些情况文章不需要有图片,我们可以通过两种方式来处理:

(1)通过图表表达文中的一些逻辑关系

如下:

(2)我们还可以提取一段内容的核心思想,进行“金句设计”。这样既可以调整节奏感,也可以方便部分用户快速浏览

如下:

2. 将目录放在 文章 的开头

我们可以在文章开头放置一个目录,让读者对文章的内容有一个宏观的概念,让读者可以选择性的访问相关内容。为什么我有这样的想法实际上来自报纸的设计方式。

报纸上的一条新闻一般有四个模块:标题、副标题、介绍和正文。它们对应不同的用户需求。

当用户有:

虽然人们的阅读方式已经从纸质阅读转向电子阅读,但实际上这种阅读习惯并没有发生实质性的改变,所以目录的作用就是帮助那些时间有限的读者筛选出最想得到的信息。

同时也可以在目录中标记(如下图),提醒用户如果没有时间看,只需要看我高亮的内容就可以得到文章60%-70% 的主要内容。

四、写在最后

其实上面的分享说到底也只是技术内容。真正写一篇文章的方式嘛,我觉得是写一篇论文的态度写每一篇文章,只要内容做的够专业,够深,才叫好< @文章。

最后附上文章写的整理记录,13000字,116张图片。当我真的一点一点看到自己的成绩时,那一刻我很开心。

我希望这个 文章 可以对你有所帮助。码字不易,请多多支持。

本文由@Master Chat Product原创发表,人人都是产品经理,未经允许禁止转载

题图来自Unsplash,基于CC0协议

全网文章 采集(免费简单易用的第三方网站采集软件采集功能简介及简介)

采集交流 • 优采云 发表了文章 • 0 个评论 • 129 次浏览 • 2022-01-12 04:07

Dedecms以其简洁、易用、高效的特点,成为众多站长建站的选择。由于系统代码和模板的开源特性,不同行业拥有大量模板的站长可以使用不同的模型。组合形成多种独特的网站。织梦自己的采集功能很不方便,已经不能满足采集目前的需求。Dedecms有自己的采集功能,功能非常有限,无法适应采集的复杂需求,经常导致网站网页空白采集 ,这对SEO人员来说是很麻烦的。所以我们完全可以使用免费好用的第三方网站采集软件来完成dede< @采集,因为得到了广大站长朋友的永久免费支持,所以是SEO圈子。良心软件为众多站长朋友带来了实实在在的流量和经济效益。小编用dedecms做采集站,收录现在15万左右,权重低一点,只有权重2,不过可以说明是做完之后SEO方法采集站起来也可以。

功能介绍:

(一)不用写采集规则关键词自动采集

SEO软件与传统的采集软件或插件完全不同。可以根据用户设置的关键词直接进行平移采集。pan 采集 的优点 > 对于关键词的不同搜索结果,可以不执行采集对一个或多个指定的采集的站点,降低搜索引擎确定采集站点是镜像站点被搜索引擎处罚的危险。

(二)各种伪原创和优化方法来提高收录率和关键词排名

自动标题、段落重排、高级混淆、自动内部链接、内容过滤、URL过滤和同义词替换等方法增强采集文章原创和改进搜索引擎收录 , 网站 权重和 关键词 排名。

(三)插件是全自动的采集无需人工干预

当用户访问你的网站时,触发程序运行,根据设置的关键字传递搜索引擎(可自定义)采集 URL,然后自动抓取网页内容,程序计算准确分析网页,丢弃不是文章内容页面的URL,提取优秀的文章内容,最后进行伪原创,导入,生成。所有这些操作程序都是完全自动化的,无需人工。干涉。在做很多内容采集的时候,也可以手动做采集来加快采集的速度。

(四)效果明显,站群首选

自动采集发布只需简单的配置,小白站长也可以轻松上手。目前功能日益完善,采集的效率越来越高,采集的效果也越来越好。

采集 对 网站 是好是坏?

网站 的内容量决定了网站 的流量。这个问题没有标准答案。百度官方也强调不要去采集看优质内容,但你可能会发现业内很多采集网站都活得好好的,但为什么有些网站采集@ > 死了吗?其实我们应该从以下几个方面来分析:

首先网站好不好跟评分有关系。我举两个不同的网站采集和一个文章的例子,为什么一个网站的页面是收录,而另一个页面没有响应? 哪里有问题?问题其实出在域名评分上,因为我们都知道一个网站是由域名加内容组成的,如果一个域名评分高,那么它的内容也比较容易收录,也就是说,我们可以说这个网站的评价很高,信任度也很高,所以你可以理解为什么同一篇文章文章发到不同的网站上,就会出现不同的结果。

了解了这种情况之后,我们来看看采集对一个网站好不好?采集 对一个 网站 开头不好,网站 我们需要大量使用原创高质量的文章 或伪原创刚上线的时候文章来完善网站的内容,等百度稳定了你的网站评分之后,我们可以适当的做一些采集,毕竟如果你靠手写文章是很不现实的,所以我们要保证网站的内容一半高质量,一半采集,这样才能满足一个网站的需求。

看完这篇文章,如果觉得不错,不妨采集一下,或者发给有需要的朋友和同事!你的一举一动都会成为小编源源不断的动力! 查看全部

全网文章 采集(免费简单易用的第三方网站采集软件采集功能简介及简介)

Dedecms以其简洁、易用、高效的特点,成为众多站长建站的选择。由于系统代码和模板的开源特性,不同行业拥有大量模板的站长可以使用不同的模型。组合形成多种独特的网站。织梦自己的采集功能很不方便,已经不能满足采集目前的需求。Dedecms有自己的采集功能,功能非常有限,无法适应采集的复杂需求,经常导致网站网页空白采集 ,这对SEO人员来说是很麻烦的。所以我们完全可以使用免费好用的第三方网站采集软件来完成dede< @采集,因为得到了广大站长朋友的永久免费支持,所以是SEO圈子。良心软件为众多站长朋友带来了实实在在的流量和经济效益。小编用dedecms做采集站,收录现在15万左右,权重低一点,只有权重2,不过可以说明是做完之后SEO方法采集站起来也可以。

功能介绍:

(一)不用写采集规则关键词自动采集

SEO软件与传统的采集软件或插件完全不同。可以根据用户设置的关键词直接进行平移采集。pan 采集 的优点 > 对于关键词的不同搜索结果,可以不执行采集对一个或多个指定的采集的站点,降低搜索引擎确定采集站点是镜像站点被搜索引擎处罚的危险。

(二)各种伪原创和优化方法来提高收录率和关键词排名

自动标题、段落重排、高级混淆、自动内部链接、内容过滤、URL过滤和同义词替换等方法增强采集文章原创和改进搜索引擎收录 , 网站 权重和 关键词 排名。

(三)插件是全自动的采集无需人工干预

当用户访问你的网站时,触发程序运行,根据设置的关键字传递搜索引擎(可自定义)采集 URL,然后自动抓取网页内容,程序计算准确分析网页,丢弃不是文章内容页面的URL,提取优秀的文章内容,最后进行伪原创,导入,生成。所有这些操作程序都是完全自动化的,无需人工。干涉。在做很多内容采集的时候,也可以手动做采集来加快采集的速度。

(四)效果明显,站群首选

自动采集发布只需简单的配置,小白站长也可以轻松上手。目前功能日益完善,采集的效率越来越高,采集的效果也越来越好。

采集 对 网站 是好是坏?

网站 的内容量决定了网站 的流量。这个问题没有标准答案。百度官方也强调不要去采集看优质内容,但你可能会发现业内很多采集网站都活得好好的,但为什么有些网站采集@ > 死了吗?其实我们应该从以下几个方面来分析:

首先网站好不好跟评分有关系。我举两个不同的网站采集和一个文章的例子,为什么一个网站的页面是收录,而另一个页面没有响应? 哪里有问题?问题其实出在域名评分上,因为我们都知道一个网站是由域名加内容组成的,如果一个域名评分高,那么它的内容也比较容易收录,也就是说,我们可以说这个网站的评价很高,信任度也很高,所以你可以理解为什么同一篇文章文章发到不同的网站上,就会出现不同的结果。

了解了这种情况之后,我们来看看采集对一个网站好不好?采集 对一个 网站 开头不好,网站 我们需要大量使用原创高质量的文章 或伪原创刚上线的时候文章来完善网站的内容,等百度稳定了你的网站评分之后,我们可以适当的做一些采集,毕竟如果你靠手写文章是很不现实的,所以我们要保证网站的内容一半高质量,一半采集,这样才能满足一个网站的需求。

看完这篇文章,如果觉得不错,不妨采集一下,或者发给有需要的朋友和同事!你的一举一动都会成为小编源源不断的动力!

全网文章 采集(全网文章采集(抓取源码+人工智能机器算法智能审核))

采集交流 • 优采云 发表了文章 • 0 个评论 • 122 次浏览 • 2022-01-06 19:04

全网文章采集(全网抓取源码+人工智能机器算法智能审核)全网抓取(抓取全网大量网页抓取文章内容,采集合法号码,

其实可以更好解决,网上最好的方式是收集所有有价值的网站的所有历史文章,然后去人工编辑筛选文章,不断重复处理重复收集,很浪费时间而且还要人工审核,不然别人随手发个好文章到你们网站就会有不少质量很差的文章了。

楼上的回答已经可以达到目的,新媒体就是要是变动多,内容丰富,所以是考验质量的。这个想法是很好的,做网站可以聚集大量爆款内容,小众网站聚集主流爆款内容。有个经验之谈就是,小众网站,但是综合排名不错的网站是有很多优质爆款内容的。新媒体可以长久发展下去,人们的共性还是比较多的,会持续不断有很多共性爆款内容,从不断的爆款内容中发现新爆款。

给你说两个方案吧,1,高质量内容变多上架到网站2,建立公众号,实现利益共享,要的内容都可以公开渠道发布。

要想提高文章的质量,要用好原创工具,如今日头条,知乎,天天快报等, 查看全部

全网文章 采集(全网文章采集(抓取源码+人工智能机器算法智能审核))

全网文章采集(全网抓取源码+人工智能机器算法智能审核)全网抓取(抓取全网大量网页抓取文章内容,采集合法号码,

其实可以更好解决,网上最好的方式是收集所有有价值的网站的所有历史文章,然后去人工编辑筛选文章,不断重复处理重复收集,很浪费时间而且还要人工审核,不然别人随手发个好文章到你们网站就会有不少质量很差的文章了。

楼上的回答已经可以达到目的,新媒体就是要是变动多,内容丰富,所以是考验质量的。这个想法是很好的,做网站可以聚集大量爆款内容,小众网站聚集主流爆款内容。有个经验之谈就是,小众网站,但是综合排名不错的网站是有很多优质爆款内容的。新媒体可以长久发展下去,人们的共性还是比较多的,会持续不断有很多共性爆款内容,从不断的爆款内容中发现新爆款。

给你说两个方案吧,1,高质量内容变多上架到网站2,建立公众号,实现利益共享,要的内容都可以公开渠道发布。

要想提高文章的质量,要用好原创工具,如今日头条,知乎,天天快报等,

全网文章 采集(新华智云首席数据官:基于MaxCompute做媒体大数据开放平台建设)

采集交流 • 优采云 发表了文章 • 0 个评论 • 129 次浏览 • 2021-12-31 08:17

摘要:随着自媒体的发展,传统媒体面临着巨大的压力和挑战。新华智云利用大数据和人工智能技术赋能传媒产业。通过媒体大数据开放平台,聚合媒体行业全网数据,借助平台数据处理能力和算法能力,向用户开放有价值的数据内容和能力。本文主要从新华智云数据核心平台、媒体行业数据特征、批处理数据架构、通用媒体大数据平台能力等几个方面介绍如何构建基于MaxCompute的媒体大数据开放平台。

演讲嘉宾简介:新华智云首席数据官李金波。负责阿里巴巴大数据通用计算平台MaxCompute(原ODPS)的框架架构。他在高可用性分布式系统的设计和开发方面拥有多年的经验。先后开发了阿里巴巴机器学习平台在线预测系统和通用大数据计算平台框架系统。精彩回顾此直播视频,请点击这里!以下内容根据演讲者的视频分享整理而成。本次分享主要集中在以下五个方面:

一、关于新华智云二、数据核心-媒体大数据开放平台三、媒体大数据平台能力四、项目依赖五、几个tips

一、关于新华智云 新华智云是新华社与阿里巴巴合资成立的公司。它专注于利用大数据和人工智能技术为媒体行业赋能。随着自媒体的发展,自媒体的公司很受欢迎。今日头条,抖音等。对于传统媒体来说,他们面临着巨大的压力和挑战。传统媒体热切希望互联网技术能够帮助他们赋能。

媒体大脑-数字核心

媒体大脑是新华智云的底层产品品牌,数据芯是媒体大脑的基础数据平台。Datachip定位为媒体大数据的开放平台,其中收录媒体行业依赖的多种数据。Datachip希望通过平台自身的数据处理能力和算法处理,将挖掘出的有价值的数据内容和能力开放给上层用户。目前数据核心收录多种数据,覆盖超过400万个互联网网站点,主要是中文站点,每天增加7000万个文章,包括微信公众号、微信博客号、图片和多媒体资源等。在平台中存储不同的资源,然后对接数据进行更多的处理和使用。“数据不再是成本,各个渠道的数据基于实体进行整合,为用户提供统一的视图。用户可以看到信息的发酵过程以及信息传播到哪里。

二、数字核心-媒体大数据开放平台

Datachip是一个开放的大数据平台,开放性主要有3点。一是数据公开。任何数据进入数核后,都会在整个大数据处理链中进行计算,结构化内容,添加标签。同时根据用户感兴趣的数据范围,对标签的特征进行过滤,过滤出用户想要的数据。Datachip帮助用户了解互联网上的信息,了解互联网上与自己相关的事件。第二,数字芯片提供智能能力的开放。用户再怎么努力,也不可能获得互联网上的所有数据;不可能每个公司都建立自己的内容大数据平台进行数据分析,不可能有算法工程师;而且公司的数据处理能力还不够。强的; 媒体大数据平台可以帮助用户处理与其相关的数据,通过算法能力获取用户关心的信息。如果用户提供了文章,Datachip可以反馈这个文章与谁有关,同一个文章传播到哪里,文章是谁写的,发布到哪里了等信息。通过开放算法能力,帮助用户应用数据能力和算法能力,提供文本反垃圾邮件服务、互联网内容结构化服务、文本内容实体识别服务、文本去重判断服务、图像字符识别服务和图像标注服务等。 . 第三,

媒体数据特征

媒体大数据具有三大特点。首先,媒体数据非常非结构化。与传统数据仓库最大的不同在于,媒体行业90%以上的数据都是非结构化的,比如文本、图片、视频等。第二,数据来源的多样性。媒体行业数据具有多种外部数据源,具有不同的数据提供方式,提供不同的数据能力。因此,需要具备强大的数据聚合能力,聚合所有数据,服务下游客户。此外,对数据有效性的要求非常高。媒体行业自然会追逐新闻热点。如果它知道一个事件是一个潜在的热点,媒体希望尽快跟踪、报道和解释这个热点。

批处理流处理组合

数据核心平台基于媒体行业数据的特点,采用批流相结合的方式,解决当前客户和业务场景的数据需求。批处理是指大量的计算,基于平台特性完成复杂模型、算法训练、长周期计算、文本实体识别、文本挖掘,利用批处理能力解决更深、更大规模的数据处理。Streaming是指流式计算,完成数据清洗、结构化、轻量计算和实时统计。一条新闻出来,信息在整个新闻流通过程中实时处理。目前数字核心的整体流量计算大约需要300毫秒,也就是一条消息从源头传来,

批流组合数据架构

数据来自不同的数据源,如API、OTS、ROS、日志、文件等,一方面需要对数据进行实时计算、文本结构、标记源、垃圾识别、实体的URL去重识别和灯光实时统计。另外,基于MaxCompute,DataHub用于在批处理平台中存储数据。由于流计算本身不做持久化存储,所有的数据都会存储在MaxCompute上。完成数据存储、主题构建、关系挖掘、知识图谱计算、算法训练。批处理和流相结合的处理方式可以满足客户对数据本身能力的需求。之后,为用户提供搜索能力、大屏能力、BI能力。三、

人们在网页上看到一条新闻,该新闻存储在数据库的字段中。比如分为新闻标题、发布网站、时间、新闻来源、情绪等。平台需要对新闻信息进行结构化,成为后续计算过程需要依赖的数据结构化字段。

主题建筑

媒体行业将按主题构建数据。平台将获取不同的数据源和不同类型的数据。这些数据不能完全结合。数据核心平台将所有数据划分为不同的主题,根据不同的主题进行构建、存储和处理。媒体是一个非常复杂的行业,对各个行业的数据都有需求。媒体需要挖掘来自许多不同行业的数据来支持新闻制作和报道。目前,Datachip专注于媒体、体育、金融、天气等主题的内部数据。一方面,Datachip 将不同的数据源聚合到平台中。另一方面,数据进来后,可以挖掘潜在的新闻点,生成选题计划,帮助用户选题等话题。

实体识别

实体识别是媒体大数据最基本的能力。Datachip目前积累的实体以人、机构、地点三类数据为中心。新闻行业和媒体行业会聚焦于某个实体,关注与该实体相关的数据能力。比如很多企业会关注与他们相关的询问,新闻是正面的还是负面的,哪些机构会发送正面信息,哪些机构会发送负面信息。只有在采集了大量数据后,才能对相关内容进行分析。实体识别场景是媒体大数据领域非常基础的能力。首先,建立实体数据库。同时,当一条新闻产生时,Digital Chip 需要实时识别新闻与哪些人、机构和地点相关。此外,Digital Core 需要采集实体之间的关系来创建实体关系图。例如,很多品牌会瞄准竞争对手,调整品牌战略。实体关系图对很多企业的品牌运营推广很有帮助。

情绪分析

情感分析也是媒体大数据平台中比较常见的能力。一条新闻出来后,用户需要知道它是正面的还是负面的。信息量少的信息可以人工判断,但是如果每天有几千篇文章,就无法人工判断最后一篇文章的内容。媒体行业的情感分析与学术情感分析是有区别的。目前自媒体发布后的短文越来越多。短文本的情感分析不同于长文本的情感分析。以前用同样的算法来实现情感分析,但是发现效果并不好。现在,Digital Core 分离了情感分析场景。Word2vec+LSTM用于微博短文本的情感分析,Word2vec+CNN+RNN用于新闻长文本的情感分析。分离后,我发现每一种情感分析的效果都有所提升。

重复内容删除

内容重复数据删除是媒体大数据平台中非常重要的一部分。去重能力是准确判断常见新闻摘录、编辑、删除重复的能力。一条新闻不是一个人写的,它会被许多组织和渠道转发。如何知道一条新闻转发到哪个渠道,其实是通过去重实现的。平台在采集了大量渠道的数据后,需要将一条新闻与前一条新闻的相似度进行比较,通过相似度的比较得出结果。最早的去重是基于关键词的对比,数据核心采用了关键词和语义的对比,去重效果显着提升。

内容标记

可以使用搜索引擎搜索新闻,关键词和文章的匹配程度决定了该内容是否推荐给用户。但单纯的搜索方式已不能满足用户的需求。今天的今日头条之所以成功,是因为它根据新闻和用户习惯推荐内容。内容标注是通过机器理解新闻,了解新闻与哪些信息相关,基于文本挖掘方法实现对全网内容数据采集的分类和标注。

四、项目依赖很多场合,很难决定是否使用大数据平台来划分项目。不分项目的好处是开发者都在同一个平台上工作,彼此之间不需要太多的授权,整体的工作效率会更高。子项目的优势在于,使用不同的平台做不同的业务,会更清晰、更有条理。Digital Chip 开始使用 MaxCompute 时,采用的是逐个项目的方法。其考虑的原因是以下三点。首先,可以通过子项目区分业务优先级,防止低优先级的任务影响高优先级的数据输出。此外,可以区分资源消耗类型,避免从整体上影响数据输出的高资源消耗任务。内部服务和外部服务之间也有区别,以避免内部服务的交叉影响。一般来说,子项目可以为数据输出的稳定性提供很好的保证。

五、一些提示

首先,由于媒体行业的数据大多是非结构化数据,所以会对单个领域的容量产生比较大的需求。而且,不同的平台和传输工具对数据的字段大小有不同的限制。从不同平台传输数据时,需要特别注意这个问题。其次,对于可以用UDF解决的问题,不要使用MR。使用UDF可以提高开发和运维的效率。即尽量使用简单的表达式处理逻辑,有利于整体数据输出的稳定性。第三,对查询效率要求不高的数据报表可以直接接入MaxCompute,减少中间环节。这样可以大大降低数据转换和数据维护的成本。第四,一方面,Datahub可以连接数据源,也可以更好地连接流之间的批处理和计算过程,以保持数据的一致性和形式依赖性。五是合理设计批处理和流数据处理分区,减少重复计算。第六,媒体大数据往往需要使用不同的算法。PAI可以帮助解决很多算法问题,减少开发工作量,提高数据处理效率。 查看全部

全网文章 采集(新华智云首席数据官:基于MaxCompute做媒体大数据开放平台建设)

摘要:随着自媒体的发展,传统媒体面临着巨大的压力和挑战。新华智云利用大数据和人工智能技术赋能传媒产业。通过媒体大数据开放平台,聚合媒体行业全网数据,借助平台数据处理能力和算法能力,向用户开放有价值的数据内容和能力。本文主要从新华智云数据核心平台、媒体行业数据特征、批处理数据架构、通用媒体大数据平台能力等几个方面介绍如何构建基于MaxCompute的媒体大数据开放平台。

演讲嘉宾简介:新华智云首席数据官李金波。负责阿里巴巴大数据通用计算平台MaxCompute(原ODPS)的框架架构。他在高可用性分布式系统的设计和开发方面拥有多年的经验。先后开发了阿里巴巴机器学习平台在线预测系统和通用大数据计算平台框架系统。精彩回顾此直播视频,请点击这里!以下内容根据演讲者的视频分享整理而成。本次分享主要集中在以下五个方面:

一、关于新华智云二、数据核心-媒体大数据开放平台三、媒体大数据平台能力四、项目依赖五、几个tips

一、关于新华智云 新华智云是新华社与阿里巴巴合资成立的公司。它专注于利用大数据和人工智能技术为媒体行业赋能。随着自媒体的发展,自媒体的公司很受欢迎。今日头条,抖音等。对于传统媒体来说,他们面临着巨大的压力和挑战。传统媒体热切希望互联网技术能够帮助他们赋能。

媒体大脑-数字核心

媒体大脑是新华智云的底层产品品牌,数据芯是媒体大脑的基础数据平台。Datachip定位为媒体大数据的开放平台,其中收录媒体行业依赖的多种数据。Datachip希望通过平台自身的数据处理能力和算法处理,将挖掘出的有价值的数据内容和能力开放给上层用户。目前数据核心收录多种数据,覆盖超过400万个互联网网站点,主要是中文站点,每天增加7000万个文章,包括微信公众号、微信博客号、图片和多媒体资源等。在平台中存储不同的资源,然后对接数据进行更多的处理和使用。“数据不再是成本,各个渠道的数据基于实体进行整合,为用户提供统一的视图。用户可以看到信息的发酵过程以及信息传播到哪里。

二、数字核心-媒体大数据开放平台

Datachip是一个开放的大数据平台,开放性主要有3点。一是数据公开。任何数据进入数核后,都会在整个大数据处理链中进行计算,结构化内容,添加标签。同时根据用户感兴趣的数据范围,对标签的特征进行过滤,过滤出用户想要的数据。Datachip帮助用户了解互联网上的信息,了解互联网上与自己相关的事件。第二,数字芯片提供智能能力的开放。用户再怎么努力,也不可能获得互联网上的所有数据;不可能每个公司都建立自己的内容大数据平台进行数据分析,不可能有算法工程师;而且公司的数据处理能力还不够。强的; 媒体大数据平台可以帮助用户处理与其相关的数据,通过算法能力获取用户关心的信息。如果用户提供了文章,Datachip可以反馈这个文章与谁有关,同一个文章传播到哪里,文章是谁写的,发布到哪里了等信息。通过开放算法能力,帮助用户应用数据能力和算法能力,提供文本反垃圾邮件服务、互联网内容结构化服务、文本内容实体识别服务、文本去重判断服务、图像字符识别服务和图像标注服务等。 . 第三,

媒体数据特征

媒体大数据具有三大特点。首先,媒体数据非常非结构化。与传统数据仓库最大的不同在于,媒体行业90%以上的数据都是非结构化的,比如文本、图片、视频等。第二,数据来源的多样性。媒体行业数据具有多种外部数据源,具有不同的数据提供方式,提供不同的数据能力。因此,需要具备强大的数据聚合能力,聚合所有数据,服务下游客户。此外,对数据有效性的要求非常高。媒体行业自然会追逐新闻热点。如果它知道一个事件是一个潜在的热点,媒体希望尽快跟踪、报道和解释这个热点。

批处理流处理组合

数据核心平台基于媒体行业数据的特点,采用批流相结合的方式,解决当前客户和业务场景的数据需求。批处理是指大量的计算,基于平台特性完成复杂模型、算法训练、长周期计算、文本实体识别、文本挖掘,利用批处理能力解决更深、更大规模的数据处理。Streaming是指流式计算,完成数据清洗、结构化、轻量计算和实时统计。一条新闻出来,信息在整个新闻流通过程中实时处理。目前数字核心的整体流量计算大约需要300毫秒,也就是一条消息从源头传来,

批流组合数据架构

数据来自不同的数据源,如API、OTS、ROS、日志、文件等,一方面需要对数据进行实时计算、文本结构、标记源、垃圾识别、实体的URL去重识别和灯光实时统计。另外,基于MaxCompute,DataHub用于在批处理平台中存储数据。由于流计算本身不做持久化存储,所有的数据都会存储在MaxCompute上。完成数据存储、主题构建、关系挖掘、知识图谱计算、算法训练。批处理和流相结合的处理方式可以满足客户对数据本身能力的需求。之后,为用户提供搜索能力、大屏能力、BI能力。三、

人们在网页上看到一条新闻,该新闻存储在数据库的字段中。比如分为新闻标题、发布网站、时间、新闻来源、情绪等。平台需要对新闻信息进行结构化,成为后续计算过程需要依赖的数据结构化字段。

主题建筑

媒体行业将按主题构建数据。平台将获取不同的数据源和不同类型的数据。这些数据不能完全结合。数据核心平台将所有数据划分为不同的主题,根据不同的主题进行构建、存储和处理。媒体是一个非常复杂的行业,对各个行业的数据都有需求。媒体需要挖掘来自许多不同行业的数据来支持新闻制作和报道。目前,Datachip专注于媒体、体育、金融、天气等主题的内部数据。一方面,Datachip 将不同的数据源聚合到平台中。另一方面,数据进来后,可以挖掘潜在的新闻点,生成选题计划,帮助用户选题等话题。

实体识别

实体识别是媒体大数据最基本的能力。Datachip目前积累的实体以人、机构、地点三类数据为中心。新闻行业和媒体行业会聚焦于某个实体,关注与该实体相关的数据能力。比如很多企业会关注与他们相关的询问,新闻是正面的还是负面的,哪些机构会发送正面信息,哪些机构会发送负面信息。只有在采集了大量数据后,才能对相关内容进行分析。实体识别场景是媒体大数据领域非常基础的能力。首先,建立实体数据库。同时,当一条新闻产生时,Digital Chip 需要实时识别新闻与哪些人、机构和地点相关。此外,Digital Core 需要采集实体之间的关系来创建实体关系图。例如,很多品牌会瞄准竞争对手,调整品牌战略。实体关系图对很多企业的品牌运营推广很有帮助。

情绪分析

情感分析也是媒体大数据平台中比较常见的能力。一条新闻出来后,用户需要知道它是正面的还是负面的。信息量少的信息可以人工判断,但是如果每天有几千篇文章,就无法人工判断最后一篇文章的内容。媒体行业的情感分析与学术情感分析是有区别的。目前自媒体发布后的短文越来越多。短文本的情感分析不同于长文本的情感分析。以前用同样的算法来实现情感分析,但是发现效果并不好。现在,Digital Core 分离了情感分析场景。Word2vec+LSTM用于微博短文本的情感分析,Word2vec+CNN+RNN用于新闻长文本的情感分析。分离后,我发现每一种情感分析的效果都有所提升。

重复内容删除

内容重复数据删除是媒体大数据平台中非常重要的一部分。去重能力是准确判断常见新闻摘录、编辑、删除重复的能力。一条新闻不是一个人写的,它会被许多组织和渠道转发。如何知道一条新闻转发到哪个渠道,其实是通过去重实现的。平台在采集了大量渠道的数据后,需要将一条新闻与前一条新闻的相似度进行比较,通过相似度的比较得出结果。最早的去重是基于关键词的对比,数据核心采用了关键词和语义的对比,去重效果显着提升。

内容标记

可以使用搜索引擎搜索新闻,关键词和文章的匹配程度决定了该内容是否推荐给用户。但单纯的搜索方式已不能满足用户的需求。今天的今日头条之所以成功,是因为它根据新闻和用户习惯推荐内容。内容标注是通过机器理解新闻,了解新闻与哪些信息相关,基于文本挖掘方法实现对全网内容数据采集的分类和标注。

四、项目依赖很多场合,很难决定是否使用大数据平台来划分项目。不分项目的好处是开发者都在同一个平台上工作,彼此之间不需要太多的授权,整体的工作效率会更高。子项目的优势在于,使用不同的平台做不同的业务,会更清晰、更有条理。Digital Chip 开始使用 MaxCompute 时,采用的是逐个项目的方法。其考虑的原因是以下三点。首先,可以通过子项目区分业务优先级,防止低优先级的任务影响高优先级的数据输出。此外,可以区分资源消耗类型,避免从整体上影响数据输出的高资源消耗任务。内部服务和外部服务之间也有区别,以避免内部服务的交叉影响。一般来说,子项目可以为数据输出的稳定性提供很好的保证。

五、一些提示

首先,由于媒体行业的数据大多是非结构化数据,所以会对单个领域的容量产生比较大的需求。而且,不同的平台和传输工具对数据的字段大小有不同的限制。从不同平台传输数据时,需要特别注意这个问题。其次,对于可以用UDF解决的问题,不要使用MR。使用UDF可以提高开发和运维的效率。即尽量使用简单的表达式处理逻辑,有利于整体数据输出的稳定性。第三,对查询效率要求不高的数据报表可以直接接入MaxCompute,减少中间环节。这样可以大大降低数据转换和数据维护的成本。第四,一方面,Datahub可以连接数据源,也可以更好地连接流之间的批处理和计算过程,以保持数据的一致性和形式依赖性。五是合理设计批处理和流数据处理分区,减少重复计算。第六,媒体大数据往往需要使用不同的算法。PAI可以帮助解决很多算法问题,减少开发工作量,提高数据处理效率。

全网文章 采集(数据采集LogHub提供30+种开箱的数据日志采集 )

采集交流 • 优采云 发表了文章 • 0 个评论 • 170 次浏览 • 2021-12-25 18:12

)

数据采集

LogHub提供30+种开箱即用的数据采集方式,包括日志、移动端、服务器端、程序、SDK、网页以及与云产品直连的嵌入式终端。在全方位的日志采集

中,我们简单介绍了各种方法。下面我们主要介绍一下物联网场景中主要涉及的两种数据采集:设备端数据采集和服务器端数据采集。

服务器数据采集

服务器日志采集由Logtail实现。Logtail 作为日志采集

代理,可以由中央服务器进行管理和控制。只需单击鼠标或 API,即可在几秒钟内向数百万台机器发出数据采集指令。

Logtail涵盖了阿里巴巴整个站点的物理机、虚拟机和容器。它每天负责数百万台服务器的数据采集。同时在阿里云公有云、友商云、用户IDC拥有数十万次安装。所有Linux版本,Window、Docker、K8S等环境;支持数十个数据源对接,体验双十一、新年红包等挑战。

得益于集团复杂场景的细化,Logtail在性能、资源消耗、可靠性、多组合隔离等硬指标上比开源代理(如Fluentd、Logstash、Beats)更先进。可满足全国最大的直播网站、最大的教育网站、最大的金融网站的严苛要求。与开源代理的主要差距在于日志格式的丰富性(当前版本的Logtail已经支持Logstash和Beats协议,这些开源插件可以无缝运行在Logtail上)。

Kubernetes 数据采集

目前,越来越多的物联网公司开始在K8S/Docker上构建服务端应用,以满足轻量级部署、快速扩展、降低运维成本的需求。Logtail 对 K8S/Docker 场景也非常友好。

Logtail针对Docker/K8S等场景做了大量适配工作,包括:

可以自豪地说,Logtail的解决方案是K8S下所有Agent中最完善、最完善的。感兴趣的可以参考LC3视角:Kubernetes下的日志采集、存储和处理技术实践。

设备端全局数据采集

C Producer Library继承了Logtail的稳定性和边界特性,可以定位为“轻量级Logtail”。虽然没有Logtail的实时配置管理和文件采集

机制,但是拥有70%的其他功能,包括:

更多关于 C Producer Library 的信息,请参考目录:

目前我们针对不同环境(如网络服务器、ARM设备、RTOS设备)从大到小提供3种解决方案:

同时,我们对Producer进行了一系列的性能和资源优化,确保数据采集可以“插”到任何IOT设备上。其中,C Producer Bricks版本达到了极限内存占用(库容量13KB,运行内存4KB以内)。

使用C Producer系列的客户包括:百万天猫精灵、儿童最爱的故事机火兔、世界码牛、钉钉路由器、兼容多平台视频播放器、实时帧图传输相机等。

这些智能 SDK 每天有超过 100 万的 DAU,分布在世界各地的设备上,每天传输数百 TB 的数据。C Producer Library的详细介绍请参考这篇文章:智能设备日志工具:嵌入式日志客户端(C Producer)发布。

全球加速数据采集

作为典型的“终端”设备,物联网设备通常部署在全国乃至全球。部署区域的网络条件难以保证。这会给数据采集带来一个巨大的问题:数据采集受网络质量影响,可靠性难以保证。.

针对以上问题,日志服务和阿里云CDN推出了全球数据上传自动加速解决方案:“基于阿里云CDN硬件资源,全球数据连接到最近的边缘节点,通过内部高速路由到LogHub通道,大大减少了网络延迟和抖动”。

该方案具有以下特点:

在我们的日志上传基准测试中,全球7个地区的整体延迟下降了50%,中东、欧洲、澳大利亚和新加坡效果明显。除了平均时延的降低,整体的稳定性也有了很大的提升(见下图,几乎没有抖动,超时请求基本是0)。确保无论何时何地在世界范围内,只要访问这个加速域名就可以高效便捷地将数据采集到想要的Region中。

关于全局加速的更多信息,请参考我们的文章:数据采集的新形式——全局加速。

查看全部

全网文章 采集(数据采集LogHub提供30+种开箱的数据日志采集

)

数据采集

LogHub提供30+种开箱即用的数据采集方式,包括日志、移动端、服务器端、程序、SDK、网页以及与云产品直连的嵌入式终端。在全方位的日志采集

中,我们简单介绍了各种方法。下面我们主要介绍一下物联网场景中主要涉及的两种数据采集:设备端数据采集和服务器端数据采集。

服务器数据采集

服务器日志采集由Logtail实现。Logtail 作为日志采集

代理,可以由中央服务器进行管理和控制。只需单击鼠标或 API,即可在几秒钟内向数百万台机器发出数据采集指令。

Logtail涵盖了阿里巴巴整个站点的物理机、虚拟机和容器。它每天负责数百万台服务器的数据采集。同时在阿里云公有云、友商云、用户IDC拥有数十万次安装。所有Linux版本,Window、Docker、K8S等环境;支持数十个数据源对接,体验双十一、新年红包等挑战。

得益于集团复杂场景的细化,Logtail在性能、资源消耗、可靠性、多组合隔离等硬指标上比开源代理(如Fluentd、Logstash、Beats)更先进。可满足全国最大的直播网站、最大的教育网站、最大的金融网站的严苛要求。与开源代理的主要差距在于日志格式的丰富性(当前版本的Logtail已经支持Logstash和Beats协议,这些开源插件可以无缝运行在Logtail上)。

Kubernetes 数据采集

目前,越来越多的物联网公司开始在K8S/Docker上构建服务端应用,以满足轻量级部署、快速扩展、降低运维成本的需求。Logtail 对 K8S/Docker 场景也非常友好。

Logtail针对Docker/K8S等场景做了大量适配工作,包括:

可以自豪地说,Logtail的解决方案是K8S下所有Agent中最完善、最完善的。感兴趣的可以参考LC3视角:Kubernetes下的日志采集、存储和处理技术实践。

设备端全局数据采集

C Producer Library继承了Logtail的稳定性和边界特性,可以定位为“轻量级Logtail”。虽然没有Logtail的实时配置管理和文件采集

机制,但是拥有70%的其他功能,包括:

更多关于 C Producer Library 的信息,请参考目录:

目前我们针对不同环境(如网络服务器、ARM设备、RTOS设备)从大到小提供3种解决方案:

同时,我们对Producer进行了一系列的性能和资源优化,确保数据采集可以“插”到任何IOT设备上。其中,C Producer Bricks版本达到了极限内存占用(库容量13KB,运行内存4KB以内)。

使用C Producer系列的客户包括:百万天猫精灵、儿童最爱的故事机火兔、世界码牛、钉钉路由器、兼容多平台视频播放器、实时帧图传输相机等。

这些智能 SDK 每天有超过 100 万的 DAU,分布在世界各地的设备上,每天传输数百 TB 的数据。C Producer Library的详细介绍请参考这篇文章:智能设备日志工具:嵌入式日志客户端(C Producer)发布。

全球加速数据采集

作为典型的“终端”设备,物联网设备通常部署在全国乃至全球。部署区域的网络条件难以保证。这会给数据采集带来一个巨大的问题:数据采集受网络质量影响,可靠性难以保证。.

针对以上问题,日志服务和阿里云CDN推出了全球数据上传自动加速解决方案:“基于阿里云CDN硬件资源,全球数据连接到最近的边缘节点,通过内部高速路由到LogHub通道,大大减少了网络延迟和抖动”。

该方案具有以下特点:

在我们的日志上传基准测试中,全球7个地区的整体延迟下降了50%,中东、欧洲、澳大利亚和新加坡效果明显。除了平均时延的降低,整体的稳定性也有了很大的提升(见下图,几乎没有抖动,超时请求基本是0)。确保无论何时何地在世界范围内,只要访问这个加速域名就可以高效便捷地将数据采集到想要的Region中。

关于全局加速的更多信息,请参考我们的文章:数据采集的新形式——全局加速。

全网文章 采集(采集规则是什么,不懂采集插件可以进行网站采集吗 )

采集交流 • 优采云 发表了文章 • 0 个评论 • 128 次浏览 • 2022-03-12 23:02

)

采集什么是规则,如果我不理解采集规则,我可以做网站采集。像我们的许多新手站长一样,博主在第一次接触 网站采集 时总会遇到听起来很复杂的正则表达式之类的规则 采集。虽然博主还一窍不通,但不影响我通过无规则采集插件完成网站data采集。

无规则采集插件操作过程可视化,无需掌握复杂的采集规则,操作页面简单,一眼就能上手,无论是图片手机或者一个自媒体论坛,整个过程可视化,满足各种采集需求。只需要关键词输入即可实现全网采集。

无规则采集插件的增量指定采集只要输入我们需要的URL采集,在插件窗口点击我们需要的采集元素就可以启动我们的数据和内容采集。采集之后的内容支持txt、html、小滚动样式保存到本地

采集规则的设置其实是为了让我们获取对我们有用的数据和内容。比如我们可以在插件中点击过滤作者信息、去除图片水印、过滤广告等。让我们采集内容干净整洁,方便我们二次加工。

当然还有一点很重要,就是采集网站标签的保留。我们的网页代码中会用到一些标签,这些标签可以用来方便蜘蛛抓取。因此,在采集过程中保留原创标签也很重要。当然,并不是所有的标签都需要保留,这些也是可选的。下面我们来看看如何巧妙地使用标签。

1、内容标签

内容标签的作用是强调文本,浏览器一般使用粗体字来表示标签的内容。

2、标题标签

标题标签定义了网页 HTML 代码中的标题。在所有页面中,博主建议该标签具有且只需要出现一次。可以定义标题,权重按降序排列。除了标签,其他标签可以重复出现。

3、alt 属性标签

准确的说应该是标签的alt属性。如果显示在网站上,也就是用户将鼠标放在图片上,浏览器会自动显示一个文本框给图片加文字。描述。我们都知道蜘蛛是不可能识别出网站中的图片的,但是如果我们在图片上加一些代码,那么就可以让蜘蛛完成对图片的一些识别,可以理解为识别图片的。一定的描述,让蜘蛛能够理解图片中的信息。当然,从关键词的角度来看,添加标签可以提高整个页面的关键词密度。

4、不关注标签

nofollow 标签是 SEO 中非常重要的标签。它的目的是告诉蜘蛛不要跟随这个页面上的链接,或者不要跟随这个特定的链接。它通常用于不在本网站上的链接。例如,我们可以将一个页面视为一个桶,而链接则是桶中的一个洞。如果桶的顶部没有孔,那么桶可以将所有的水都储存在里面。如果桶中的孔洞很多,会导致桶中的水快速流失。给链接加上nofollow标签,就相当于修补了这些漏洞,让蜘蛛不会跟随这些链接。

不通过采集规则的网站数据和文章采集的共享到此结束。当然,免规则采集不仅有标签保留等功能,文章采集@文章伪原创,图片加水印等也可以使用. 本文主要介绍采集规则中大家比较关心的几个问题。标签的保留可以降低我们二次创作的难度。相关优化提高了我们的 文章原创 度数。整个网站的优化就是通过这些小细节一点一点打造的。所以在网站优化的过程中也要注意细节,分享就到这里,欢迎一键连接!

查看全部

全网文章 采集(采集规则是什么,不懂采集插件可以进行网站采集吗

)

采集什么是规则,如果我不理解采集规则,我可以做网站采集。像我们的许多新手站长一样,博主在第一次接触 网站采集 时总会遇到听起来很复杂的正则表达式之类的规则 采集。虽然博主还一窍不通,但不影响我通过无规则采集插件完成网站data采集。

无规则采集插件操作过程可视化,无需掌握复杂的采集规则,操作页面简单,一眼就能上手,无论是图片手机或者一个自媒体论坛,整个过程可视化,满足各种采集需求。只需要关键词输入即可实现全网采集。

无规则采集插件的增量指定采集只要输入我们需要的URL采集,在插件窗口点击我们需要的采集元素就可以启动我们的数据和内容采集。采集之后的内容支持txt、html、小滚动样式保存到本地

采集规则的设置其实是为了让我们获取对我们有用的数据和内容。比如我们可以在插件中点击过滤作者信息、去除图片水印、过滤广告等。让我们采集内容干净整洁,方便我们二次加工。

当然还有一点很重要,就是采集网站标签的保留。我们的网页代码中会用到一些标签,这些标签可以用来方便蜘蛛抓取。因此,在采集过程中保留原创标签也很重要。当然,并不是所有的标签都需要保留,这些也是可选的。下面我们来看看如何巧妙地使用标签。

1、内容标签

内容标签的作用是强调文本,浏览器一般使用粗体字来表示标签的内容。

2、标题标签

标题标签定义了网页 HTML 代码中的标题。在所有页面中,博主建议该标签具有且只需要出现一次。可以定义标题,权重按降序排列。除了标签,其他标签可以重复出现。

3、alt 属性标签

准确的说应该是标签的alt属性。如果显示在网站上,也就是用户将鼠标放在图片上,浏览器会自动显示一个文本框给图片加文字。描述。我们都知道蜘蛛是不可能识别出网站中的图片的,但是如果我们在图片上加一些代码,那么就可以让蜘蛛完成对图片的一些识别,可以理解为识别图片的。一定的描述,让蜘蛛能够理解图片中的信息。当然,从关键词的角度来看,添加标签可以提高整个页面的关键词密度。

4、不关注标签

nofollow 标签是 SEO 中非常重要的标签。它的目的是告诉蜘蛛不要跟随这个页面上的链接,或者不要跟随这个特定的链接。它通常用于不在本网站上的链接。例如,我们可以将一个页面视为一个桶,而链接则是桶中的一个洞。如果桶的顶部没有孔,那么桶可以将所有的水都储存在里面。如果桶中的孔洞很多,会导致桶中的水快速流失。给链接加上nofollow标签,就相当于修补了这些漏洞,让蜘蛛不会跟随这些链接。

不通过采集规则的网站数据和文章采集的共享到此结束。当然,免规则采集不仅有标签保留等功能,文章采集@文章伪原创,图片加水印等也可以使用. 本文主要介绍采集规则中大家比较关心的几个问题。标签的保留可以降低我们二次创作的难度。相关优化提高了我们的 文章原创 度数。整个网站的优化就是通过这些小细节一点一点打造的。所以在网站优化的过程中也要注意细节,分享就到这里,欢迎一键连接!

全网文章 采集(利用白帽SEO优化方法快速提升网站权重值的方法有哪些)

采集交流 • 优采云 发表了文章 • 0 个评论 • 110 次浏览 • 2022-02-28 19:25

文章采集,让网站有内容,只有有内容才有收录,收录才有条件提升网站重量。网站权重是对网站综合价值的总称,包括网站运营能力、用户体验、内容质量、用户热度、SEO指标。综合性能统一名称。

文章采集如何增加网站的权重:日常正规管理和操作网站,使用正规白帽方法操作网站,比如更新内容,检查和维护操作等。这些都是站长必须做的事情。挖矿优化精准关键词,根据自己的网站行业,挖矿优化精准网站关键词,必须有流量关键词,如果挖矿关键词@ >与网站的主题定位无关,那么网站的权重就很难增加,甚至网站都会被搜索引擎惩罚。

文章采集改进网站和收录的内容,网站收录索引数据与网站@的更新次数成正比> content 是的,如果你长时间不更新网站,那么你的网站索引数据不仅会增加,还会减少。如果你想改进网站收录的内容,那么你需要不断更新网站优质内容。

同时,站内和站外的SEO也需要做好。除了文章采集,还要更新内容,内链优化,网站结构优化,404、网站sitemap地图和机器人都是都在现场搜索引擎优化的范畴。如果你不做好站内优化,你的外链再好也没用,因为你的网站留不住用户,所以站内优化大于站外-网站优化,而外部链接的作用近年来逐渐减弱。如果想通过累计外链数量来增加网站的权重,目前可能很难实现。

使用白帽SEO进行形式优化,为什么一定要使用白帽SEO来优化网站?因为有的站长想用黑帽SEO优化的方法来快速提升网站的权重值,如果使用这些黑帽SEO,一旦被搜索引擎发现,就等待网站@的结果> 只能被惩罚或K站。搜索引擎支持用户使用正式的白帽SEO优化方式,因为这种优化方式可以持续为用户提供有价值的内容。

我们在优化网站的时候,建议不要用黑帽作弊来优化网站,因为到最后你很可能会花费时间和精力,却没有网站好的流量。

<p>新站前期以文章采集和挖矿网站长尾关键词为主。长尾关键词不仅竞争程度低,而且排名时间短。优化长尾关键词可能只需要几个星期,最长不会超过一个月。新站没有优化基础,搜索引擎对新站信任度不高。我们优化关键词@文章采集和长尾关键词,可以实现更快的收录网站页面,更快的流量,然后不断的积累和提高网站的流量和权重,最后为了争夺一些高指数、高流量的关键词,新的网站倾向于前期做内容, 查看全部

全网文章 采集(利用白帽SEO优化方法快速提升网站权重值的方法有哪些)

文章采集,让网站有内容,只有有内容才有收录,收录才有条件提升网站重量。网站权重是对网站综合价值的总称,包括网站运营能力、用户体验、内容质量、用户热度、SEO指标。综合性能统一名称。

文章采集如何增加网站的权重:日常正规管理和操作网站,使用正规白帽方法操作网站,比如更新内容,检查和维护操作等。这些都是站长必须做的事情。挖矿优化精准关键词,根据自己的网站行业,挖矿优化精准网站关键词,必须有流量关键词,如果挖矿关键词@ >与网站的主题定位无关,那么网站的权重就很难增加,甚至网站都会被搜索引擎惩罚。

文章采集改进网站和收录的内容,网站收录索引数据与网站@的更新次数成正比> content 是的,如果你长时间不更新网站,那么你的网站索引数据不仅会增加,还会减少。如果你想改进网站收录的内容,那么你需要不断更新网站优质内容。

同时,站内和站外的SEO也需要做好。除了文章采集,还要更新内容,内链优化,网站结构优化,404、网站sitemap地图和机器人都是都在现场搜索引擎优化的范畴。如果你不做好站内优化,你的外链再好也没用,因为你的网站留不住用户,所以站内优化大于站外-网站优化,而外部链接的作用近年来逐渐减弱。如果想通过累计外链数量来增加网站的权重,目前可能很难实现。

使用白帽SEO进行形式优化,为什么一定要使用白帽SEO来优化网站?因为有的站长想用黑帽SEO优化的方法来快速提升网站的权重值,如果使用这些黑帽SEO,一旦被搜索引擎发现,就等待网站@的结果> 只能被惩罚或K站。搜索引擎支持用户使用正式的白帽SEO优化方式,因为这种优化方式可以持续为用户提供有价值的内容。

我们在优化网站的时候,建议不要用黑帽作弊来优化网站,因为到最后你很可能会花费时间和精力,却没有网站好的流量。

<p>新站前期以文章采集和挖矿网站长尾关键词为主。长尾关键词不仅竞争程度低,而且排名时间短。优化长尾关键词可能只需要几个星期,最长不会超过一个月。新站没有优化基础,搜索引擎对新站信任度不高。我们优化关键词@文章采集和长尾关键词,可以实现更快的收录网站页面,更快的流量,然后不断的积累和提高网站的流量和权重,最后为了争夺一些高指数、高流量的关键词,新的网站倾向于前期做内容,

全网文章 采集(全网文章采集策略实现爬虫,把你喜欢的文章)

采集交流 • 优采云 发表了文章 • 0 个评论 • 125 次浏览 • 2022-02-27 01:01

全网文章采集抓取,把你喜欢的文章按照标题、作者、类型、摘要进行汇总分析。文章采集策略实现爬虫,抓取全网高质量的文章及网站全部内容。

是需要找个国外的it公司的top10的网站的内容进行抓取,如果不方便的话我建议使用系统自带的api,因为在手机端自己去抓取的话可能会有各种的杂乱问题或者遗漏数据。我们团队用scrapy+webdriver做了一套网页爬虫。我自己编写的爬虫如下:代码如下:爬虫:github-zengwxjj/scrapy:scrapyutilityforpython,java,php,ruby,f#,mysql,sqlite,sqlitemysqlserver,oracle,mysql,db2,access,impala,postgresql,oracle,hadoopandmapreduce-java//获取全网数据抓取,增强db的功能,爬取web蜘蛛端的tokens,数据字典和sql解析scrapy-db功能保存sitetokens,json,jsonp,xml,jsonpath爬取信息myblogajax-ajax保存重定向代码:python的db还支持动态sql语句===我发现我太激动了,已经脱离苦海,立刻让anna大大来救我回去=anna大大欢迎您参与反爬不挂乎。 查看全部

全网文章 采集(全网文章采集策略实现爬虫,把你喜欢的文章)

全网文章采集抓取,把你喜欢的文章按照标题、作者、类型、摘要进行汇总分析。文章采集策略实现爬虫,抓取全网高质量的文章及网站全部内容。

是需要找个国外的it公司的top10的网站的内容进行抓取,如果不方便的话我建议使用系统自带的api,因为在手机端自己去抓取的话可能会有各种的杂乱问题或者遗漏数据。我们团队用scrapy+webdriver做了一套网页爬虫。我自己编写的爬虫如下:代码如下:爬虫:github-zengwxjj/scrapy:scrapyutilityforpython,java,php,ruby,f#,mysql,sqlite,sqlitemysqlserver,oracle,mysql,db2,access,impala,postgresql,oracle,hadoopandmapreduce-java//获取全网数据抓取,增强db的功能,爬取web蜘蛛端的tokens,数据字典和sql解析scrapy-db功能保存sitetokens,json,jsonp,xml,jsonpath爬取信息myblogajax-ajax保存重定向代码:python的db还支持动态sql语句===我发现我太激动了,已经脱离苦海,立刻让anna大大来救我回去=anna大大欢迎您参与反爬不挂乎。

全网文章 采集(服务器的常规操作应该是怎样的?-全网)

采集交流 • 优采云 发表了文章 • 0 个评论 • 122 次浏览 • 2022-02-22 10:00

全网文章采集:微信公众号:wisdom-linked,知乎专栏:;希望有助于你的理解。注意,

举例read_info把所有自己感兴趣的数据read进来做筛选

1.代码md5加密;这个也可以用第三方库:secretjs。2.自己写js插件。

通过常规方法是是通过js插件来进行处理,但是如果你是公司内部服务器,基本上没有太大的意义。

服务器的常规操作应该也是这样的步骤:1.获取cookie/注册cookie(第三方服务例如jwt或者sessionforever)2.显示相关html内容

一般跟登录一样,如果你自己写js插件的话,可以自己写一个程序通过cookie对原本的cookie进行加密生成apikey,然后通过apikey对服务器的数据库进行提取,然后匹配出相应的就是你想要的数据了。有些公司有需求就会自己出此类相关的接口,

这要算防破解的话,其实生活中我们这一行也有防破解的东西。还有个应用,貌似叫p2p。平时一些无线传输还有你通过wifi连接上,然后数据传输也都会破解的。

你这么想想,这里还是用java来写。首先我们要先进行api接口注册获取访问许可,接着要明确安全认证的模式,nginx做nginx的反向代理认证机制,然后就是浏览器或者lnmp服务器做端口映射与v4.7及更高版本的ssl加密。同时可以考虑用一些比较好的cookie接收服务器进行嗅探。只要找到nginx或者其他服务器,让它的程序去请求这个应用就行了。

要是面试的话。可以说。ssh会什么就能干什么。可以是windows\aix\linux\x11\x12等等。 查看全部

全网文章 采集(服务器的常规操作应该是怎样的?-全网)

全网文章采集:微信公众号:wisdom-linked,知乎专栏:;希望有助于你的理解。注意,

举例read_info把所有自己感兴趣的数据read进来做筛选

1.代码md5加密;这个也可以用第三方库:secretjs。2.自己写js插件。

通过常规方法是是通过js插件来进行处理,但是如果你是公司内部服务器,基本上没有太大的意义。

服务器的常规操作应该也是这样的步骤:1.获取cookie/注册cookie(第三方服务例如jwt或者sessionforever)2.显示相关html内容

一般跟登录一样,如果你自己写js插件的话,可以自己写一个程序通过cookie对原本的cookie进行加密生成apikey,然后通过apikey对服务器的数据库进行提取,然后匹配出相应的就是你想要的数据了。有些公司有需求就会自己出此类相关的接口,

这要算防破解的话,其实生活中我们这一行也有防破解的东西。还有个应用,貌似叫p2p。平时一些无线传输还有你通过wifi连接上,然后数据传输也都会破解的。

你这么想想,这里还是用java来写。首先我们要先进行api接口注册获取访问许可,接着要明确安全认证的模式,nginx做nginx的反向代理认证机制,然后就是浏览器或者lnmp服务器做端口映射与v4.7及更高版本的ssl加密。同时可以考虑用一些比较好的cookie接收服务器进行嗅探。只要找到nginx或者其他服务器,让它的程序去请求这个应用就行了。

要是面试的话。可以说。ssh会什么就能干什么。可以是windows\aix\linux\x11\x12等等。

全网文章 采集(极客邦新产品——极客搜索,整合技术文章资源)

采集交流 • 优采云 发表了文章 • 0 个评论 • 145 次浏览 • 2022-02-20 12:30

最近Geekbang发布了一款新产品——Geek Search,它整合了Geekbang下面的技术文章资源。抱着尝鲜的态度,我也试了一下,发现搜索速度很快。分析了为什么这么快,主要有两点:1、资源太少了!!!,12个公众号加起来5161篇文章;2、使用Vue框架,异步加载数据。这个产品还是很好用的,推荐一下,希望能尽快添加可搜索的技术资源。

最近在想采集some文章做分词。接口是vue写的,所以所有的数据都要经过接口,所以数据采集很方便,所以一时兴起,趁着产品刚刚上线,防爬机制不应该强,所以我采集Geekbang的所有公众号数据。一:文章采集

主要分为两个步骤,采集文章链接和原文采集。

1、采集文章链接,通过搜索界面,抓取所有文章链接

从返回的数据中可以抓取到文章原文的链接,接下来就是链接到采集原文的数据了。

2、原创资料采集

使用scrapy框架对采集微信文章数据,共采集5151篇文章。

具体代码见文末地址

二:数据分析

接下来,我对采集的文章做了一些简单的统计。

1、哪个公众号写的最多文章

infoQ 写的文章最多,998 篇,占 19.35%。StuQ以835篇排名第二,占比16.19%,EGONetworks以802篇排名第三,占比15.55%。这三个部分恰好是极客科技的三大业务。

2、每天文章 帖子的总数

随着运营的公众号越来越多,文章的数量不断攀升,2017年达到每月250多个,编辑能力非常强大。

统计每天发布文章的数量:非常规律,周一到周五多,周六周日少。那些在周六和周日努力工作的人。

3、文章词频统计

对所有文章进行分词,然后统计词频。

Top 10:我们、一、数据、技术、能、服务、使用、需要、问题、系统

前 10 个单词是:我们需要一个系统来解决技术或数据问题。是在暗示什么吗?我可以开发一个供您使用吗?商机就在这里。由于分词的结果还没有调整,所以有很多常用的修饰语等等。以后再做是一项体力消耗大的工作。

4、作者统计

基于 文章 的作者的统计。前 10 名:StuQ、EGO、InfoQ、徐川、大家硕、陈圆圆、Q News、Indigo K & Guo Liang、Stark Academy、Daniel V Classroom。

5、文章头条新闻

文章标题的命名也反映了时间的趋势,所以我把文章的标题全部提取出来,做了分词,自定义jieba的字典,去掉了很多修饰符等等,得到了下面的结果。

2015年:技术排名第一,这也符合Geekbang的特点。微直播和微课堂的提及很多,主要是因为StuQ的公众号上的广告太多了。当然,你也可以看到一些过去的流行词,比如互联网金融、大数据、创业、容器技术等。

2016年:技术依旧稳居第一,云计算、开源等词出现,也出现了阿里、AWS、百度、京东等国内大公司。

2017:变化离不开技术。同时,机器学习、深度学习、人工智能、AI等词汇的使用量有所增加,符合当下的学习热潮。

从标题文章的命名来看,极客帮微信公众号的内容基本紧跟最新科技潮流。把握技术发展趋势,分析头条。

三:总结

本文的主要工作是数据采集和分析。对于数据采集,难度不大,用scrapy可以很快搞定。数据分析很费时间,我只做了一些简单的统计。后续会在数据的基础上做一些文本相关性分析。

数据的展示地址,源码也已经放到github上,crawler-geekbang/geekbang at master·xuxping/crawler-geekbang·GitHub 查看全部

全网文章 采集(极客邦新产品——极客搜索,整合技术文章资源)

最近Geekbang发布了一款新产品——Geek Search,它整合了Geekbang下面的技术文章资源。抱着尝鲜的态度,我也试了一下,发现搜索速度很快。分析了为什么这么快,主要有两点:1、资源太少了!!!,12个公众号加起来5161篇文章;2、使用Vue框架,异步加载数据。这个产品还是很好用的,推荐一下,希望能尽快添加可搜索的技术资源。

最近在想采集some文章做分词。接口是vue写的,所以所有的数据都要经过接口,所以数据采集很方便,所以一时兴起,趁着产品刚刚上线,防爬机制不应该强,所以我采集Geekbang的所有公众号数据。一:文章采集

主要分为两个步骤,采集文章链接和原文采集。

1、采集文章链接,通过搜索界面,抓取所有文章链接

从返回的数据中可以抓取到文章原文的链接,接下来就是链接到采集原文的数据了。

2、原创资料采集

使用scrapy框架对采集微信文章数据,共采集5151篇文章。

具体代码见文末地址

二:数据分析

接下来,我对采集的文章做了一些简单的统计。

1、哪个公众号写的最多文章

infoQ 写的文章最多,998 篇,占 19.35%。StuQ以835篇排名第二,占比16.19%,EGONetworks以802篇排名第三,占比15.55%。这三个部分恰好是极客科技的三大业务。

2、每天文章 帖子的总数

随着运营的公众号越来越多,文章的数量不断攀升,2017年达到每月250多个,编辑能力非常强大。

统计每天发布文章的数量:非常规律,周一到周五多,周六周日少。那些在周六和周日努力工作的人。

3、文章词频统计

对所有文章进行分词,然后统计词频。

Top 10:我们、一、数据、技术、能、服务、使用、需要、问题、系统

前 10 个单词是:我们需要一个系统来解决技术或数据问题。是在暗示什么吗?我可以开发一个供您使用吗?商机就在这里。由于分词的结果还没有调整,所以有很多常用的修饰语等等。以后再做是一项体力消耗大的工作。

4、作者统计

基于 文章 的作者的统计。前 10 名:StuQ、EGO、InfoQ、徐川、大家硕、陈圆圆、Q News、Indigo K & Guo Liang、Stark Academy、Daniel V Classroom。

5、文章头条新闻

文章标题的命名也反映了时间的趋势,所以我把文章的标题全部提取出来,做了分词,自定义jieba的字典,去掉了很多修饰符等等,得到了下面的结果。

2015年:技术排名第一,这也符合Geekbang的特点。微直播和微课堂的提及很多,主要是因为StuQ的公众号上的广告太多了。当然,你也可以看到一些过去的流行词,比如互联网金融、大数据、创业、容器技术等。

2016年:技术依旧稳居第一,云计算、开源等词出现,也出现了阿里、AWS、百度、京东等国内大公司。

2017:变化离不开技术。同时,机器学习、深度学习、人工智能、AI等词汇的使用量有所增加,符合当下的学习热潮。

从标题文章的命名来看,极客帮微信公众号的内容基本紧跟最新科技潮流。把握技术发展趋势,分析头条。

三:总结

本文的主要工作是数据采集和分析。对于数据采集,难度不大,用scrapy可以很快搞定。数据分析很费时间,我只做了一些简单的统计。后续会在数据的基础上做一些文本相关性分析。

数据的展示地址,源码也已经放到github上,crawler-geekbang/geekbang at master·xuxping/crawler-geekbang·GitHub

全网文章 采集(网址早期要想百度收录和排行速率不清除会出现)

采集交流 • 优采云 发表了文章 • 0 个评论 • 101 次浏览 • 2022-02-19 07:07

在网站早期,如果百度收录和排名率没有迅速清零,相关领域的内容文章会大量采集。很多网站站长尝试的结果是,早期适当采集了一些文章内容来提高文章内容的字数,但是一味的采集太多文章并发布会对大家的网站造成非常严重的不良影响。

“采集文章内容一时爽,一直采集总是爽。” 过多采集 文章 并将其发布到 URL 会导致以下危害:

一、百度收录不稳定

是最直接的伤害,也算是百度搜索引擎对网站的“小惩罚”。百度收录不稳定的主要表现是今天百度收录有2~3篇,明天就删了。如果掉百度收录的内容,百度收录将无法提量,排名更难。

二、排名不能提,一上来就不稳定

这是基于第一点。百度收录排名不稳定。不利的影响是利润不稳定,更难获得高薪头寸或高回报。

三、搜索引擎蜘蛛爬了,但是爬不了

分析URL日志会发现,搜索引擎蜘蛛会抓取经常采集文章内容的网页,但时间长了就不容易抓取了,会消耗资源。就是跟随搜索引擎蜘蛛的爬行规律,这无疑是一种错误的个人行为。

四、降低功率损失

这一直是百度搜索引擎的“忍耐级别”。长期采集导致网站百度收录排名不稳定,搜索引擎蜘蛛每次都无法获取到想要的内容。从搜索引擎蜘蛛讨厌的网站到客户讨厌的网站。这时候百度搜索会掉掉之前所有的排名,甚至会立即将你踢出千名,也就是降级处分。被降级的处罚是网站遇到的最严重的问题。如果一个网站被降级,就不可能恢复基础。

网站内采集过多文章内容最严重的不利影响是降级处罚,被屏蔽的网站域名和被删除的网站因采集而不易打开,所以不得不公告采集文章的内容很可能对网站造成严重危害。

毫无疑问,如今文章对于URL的相关内容和排名尤为重要,所以销售市场上的很多采集工具都幸存下来了,比如新闻URL,比如一些灰色行业,< @关键词排名是他们领域的一个特点。这时,采集成为大家的首选方式。一个网站速重保值2、3 用一两个月尽快进行 获利后百度搜索发现他被降级处分,然后改批< @网站 域名并再次操作。

领域不一样,每个人的选择和目标都不一样,但是采集过多带来的不利影响都是一样的,所以大家在采集之前要衡量一下是否非常值得。 查看全部

全网文章 采集(网址早期要想百度收录和排行速率不清除会出现)

在网站早期,如果百度收录和排名率没有迅速清零,相关领域的内容文章会大量采集。很多网站站长尝试的结果是,早期适当采集了一些文章内容来提高文章内容的字数,但是一味的采集太多文章并发布会对大家的网站造成非常严重的不良影响。

“采集文章内容一时爽,一直采集总是爽。” 过多采集 文章 并将其发布到 URL 会导致以下危害:

一、百度收录不稳定

是最直接的伤害,也算是百度搜索引擎对网站的“小惩罚”。百度收录不稳定的主要表现是今天百度收录有2~3篇,明天就删了。如果掉百度收录的内容,百度收录将无法提量,排名更难。

二、排名不能提,一上来就不稳定

这是基于第一点。百度收录排名不稳定。不利的影响是利润不稳定,更难获得高薪头寸或高回报。

三、搜索引擎蜘蛛爬了,但是爬不了

分析URL日志会发现,搜索引擎蜘蛛会抓取经常采集文章内容的网页,但时间长了就不容易抓取了,会消耗资源。就是跟随搜索引擎蜘蛛的爬行规律,这无疑是一种错误的个人行为。

四、降低功率损失

这一直是百度搜索引擎的“忍耐级别”。长期采集导致网站百度收录排名不稳定,搜索引擎蜘蛛每次都无法获取到想要的内容。从搜索引擎蜘蛛讨厌的网站到客户讨厌的网站。这时候百度搜索会掉掉之前所有的排名,甚至会立即将你踢出千名,也就是降级处分。被降级的处罚是网站遇到的最严重的问题。如果一个网站被降级,就不可能恢复基础。

网站内采集过多文章内容最严重的不利影响是降级处罚,被屏蔽的网站域名和被删除的网站因采集而不易打开,所以不得不公告采集文章的内容很可能对网站造成严重危害。

毫无疑问,如今文章对于URL的相关内容和排名尤为重要,所以销售市场上的很多采集工具都幸存下来了,比如新闻URL,比如一些灰色行业,< @关键词排名是他们领域的一个特点。这时,采集成为大家的首选方式。一个网站速重保值2、3 用一两个月尽快进行 获利后百度搜索发现他被降级处分,然后改批< @网站 域名并再次操作。

领域不一样,每个人的选择和目标都不一样,但是采集过多带来的不利影响都是一样的,所以大家在采集之前要衡量一下是否非常值得。

全网文章 采集(怎么用WordPress采集插件把关键词优化到首页让网站能快速收录 )

采集交流 • 优采云 发表了文章 • 0 个评论 • 135 次浏览 • 2022-02-16 15:07

)

我们每个人都希望自己的事业一帆风顺,但在现实中,没有一帆风顺的事情,在工作的过程中或多或少都会遇到一些困难。那么,从事SEO工作的新手通常会遇到哪些困难呢?以及什么样的解决方案?首先我们来解决网站内容的问题,如何使用WordPress的采集插件将关键词优化到首页,让网站可以快速收录,该插件收录 SEO 功能,支持所有 网站 使用。

这个WordPress采集插件不需要学习更多的专业技能,只需要几个简单的步骤就可以轻松实现采集内容数据,用户只需要对WordPress采集插件进行简单的设置, 并完成之后,WordPress采集 插件会根据用户设置的关键词 对内容和图片进行高精度匹配。您可以选择保存在本地,也可以选择伪原创后发布,提供方便快捷的内容采集伪原创发布服务!!

相比其他WordPress采集插件,这个WordPress采集插件基本没有门槛,不需要花很多时间学习正则表达式或者html标签,一分钟就能上手,只需输入关键词即可实现采集(WordPress采集插件也自带关键词采集功能)。一路挂断!设置任务自动执行采集伪原创发布和推送任务。

几十万个不同的cms网站可以统一管理。一个人维护数百个 网站文章 更新也不是问题。

这类WordPress采集发布插件工具还配备了很多SEO功能。通过软件采集伪原创发布时,还可以提升很多SEO优化。

例如:设置自动下载图片保存在本地或第三方(使内容不再有对方的外链)。自动内链(让搜索引擎更深入地抓取你的链接)、内容或标题插入,以及网站内容插入或随机作者、随机阅读等,形成一个“高原创”。

这些SEO小功能不仅提高了网站页面原创的度数,还间接提升了网站的收录排名。您可以通过软件工具上的监控管理直接查看文章采集的发布状态,不再需要每天登录网站后台查看。目前博主亲测软件是免费的,可以直接下载使用!

1.获取网站的流量

当我们在思考如何解决工作中的烦恼的时候,还需要思考另外一个问题,就是我们每天在SEO这个领域如何获得比较高的价值,而这些价值是我们自己通过实战,而不是基于理论的海市蜃楼。

作为一个SEO运营商,我认为快速获取目标网站的流量是当下的重中之重,所以我们可能还需要注意以下几点:

一个。掌握各个行业的SEO基础知识,尤其是基于整个网站的关键词布局。

湾。不断提升自己的SEO写作思维和能力,快速写出具有排名能力的优质原创文章内容。

C、多看多读多写,学会整合资源,用它在短时间内搭建大量优质的外链。

d。了解如何使用社交媒体和 ppc 竞价对这些相关的网络营销推广渠道进行排名。

2.对数据做统计分析

在运营SEO的过程中,我们已经成功的解决了这个问题。我们认为这是一个快速的进步。然而,数据统计和分析在这个过程中更为重要。只有这样,我们才能更好、更有效地计算ROI,制定我们的短期和长期战略规划,所以我们还需要掌握以下几个问题:

①.网站流量统计分析

我们需要学会理解网站流量统计报表,甚至要善于分析这些数据指标对网站现阶段及后期阶段的长期影响。

②.网站热图分析

说到网站热力图的概念,相信还是没几个人关注,虽然数据级的跳出率、点击率、页面停留时间直观地反映了用户对单条的偏好页。

但是热图分析有助于我们清楚地了解用户对整个站点上某个主题的偏好。

③.网站日志分析

说到网站日志分析,我们可以从技术角度回顾一个网站,你会清楚地看到你网站上哪些内容不利于长期发展,比如:有有很多死链接,404页面等。

3.网站 的安全措施

目前,我认为 网站 安全方法是我们运营 SEO 增长路径中的障碍或绊脚石。我们相信每一位SEO人员都会遇到这样的挫折和烦恼。那么我们需要注意的问题是:

①.网站在长期DDOS攻击中,CPU使用率高达95%,页面加载缓慢、异常、卡顿。

②。网站中的某个页面被百度快照劫持,部分页面可能被恶意添加黑链接和木马。

③.网站优质文章内容重度采集,甚至全站镜像。

④.排名较高的关键词经常被对手恶意操纵。

以上相关问题都是我们工作中的困扰。要想不断进步,做得更好,就需要不断努力,积累相关知识来解决这些问题。

4.继续努力,积极进取

我们想要一种有效的方法来快速摆脱麻烦。我觉得我们应该不断的努力,不断的学习,与同行业的大佬们互动,不断的练习。只有实践,才能有更多的经验,来做SEO。总结经验,才能快速进步。

SEO总结:不管你从事什么行业,都是一样的,每天都会面临各种各样的烦恼。SEO合作伙伴也是如此。在不同的工作环境中会有一些麻烦。这个时候,我们需要冷静的头脑。理清思路,有针对性的解决烦恼,以上是奶茶妹根据以往的SEO经验分享给大家,仅供参考,希望对大家有所帮助!看完这篇文章,如果觉得不错,不妨采集一下,或者发给需要的朋友同事。每天跟着博主为你展示各种SEO经验,打通你的两条血脉!

查看全部

全网文章 采集(怎么用WordPress采集插件把关键词优化到首页让网站能快速收录

)

我们每个人都希望自己的事业一帆风顺,但在现实中,没有一帆风顺的事情,在工作的过程中或多或少都会遇到一些困难。那么,从事SEO工作的新手通常会遇到哪些困难呢?以及什么样的解决方案?首先我们来解决网站内容的问题,如何使用WordPress的采集插件将关键词优化到首页,让网站可以快速收录,该插件收录 SEO 功能,支持所有 网站 使用。

这个WordPress采集插件不需要学习更多的专业技能,只需要几个简单的步骤就可以轻松实现采集内容数据,用户只需要对WordPress采集插件进行简单的设置, 并完成之后,WordPress采集 插件会根据用户设置的关键词 对内容和图片进行高精度匹配。您可以选择保存在本地,也可以选择伪原创后发布,提供方便快捷的内容采集伪原创发布服务!!

相比其他WordPress采集插件,这个WordPress采集插件基本没有门槛,不需要花很多时间学习正则表达式或者html标签,一分钟就能上手,只需输入关键词即可实现采集(WordPress采集插件也自带关键词采集功能)。一路挂断!设置任务自动执行采集伪原创发布和推送任务。

几十万个不同的cms网站可以统一管理。一个人维护数百个 网站文章 更新也不是问题。

这类WordPress采集发布插件工具还配备了很多SEO功能。通过软件采集伪原创发布时,还可以提升很多SEO优化。

例如:设置自动下载图片保存在本地或第三方(使内容不再有对方的外链)。自动内链(让搜索引擎更深入地抓取你的链接)、内容或标题插入,以及网站内容插入或随机作者、随机阅读等,形成一个“高原创”。

这些SEO小功能不仅提高了网站页面原创的度数,还间接提升了网站的收录排名。您可以通过软件工具上的监控管理直接查看文章采集的发布状态,不再需要每天登录网站后台查看。目前博主亲测软件是免费的,可以直接下载使用!

1.获取网站的流量

当我们在思考如何解决工作中的烦恼的时候,还需要思考另外一个问题,就是我们每天在SEO这个领域如何获得比较高的价值,而这些价值是我们自己通过实战,而不是基于理论的海市蜃楼。

作为一个SEO运营商,我认为快速获取目标网站的流量是当下的重中之重,所以我们可能还需要注意以下几点:

一个。掌握各个行业的SEO基础知识,尤其是基于整个网站的关键词布局。

湾。不断提升自己的SEO写作思维和能力,快速写出具有排名能力的优质原创文章内容。

C、多看多读多写,学会整合资源,用它在短时间内搭建大量优质的外链。

d。了解如何使用社交媒体和 ppc 竞价对这些相关的网络营销推广渠道进行排名。

2.对数据做统计分析

在运营SEO的过程中,我们已经成功的解决了这个问题。我们认为这是一个快速的进步。然而,数据统计和分析在这个过程中更为重要。只有这样,我们才能更好、更有效地计算ROI,制定我们的短期和长期战略规划,所以我们还需要掌握以下几个问题:

①.网站流量统计分析

我们需要学会理解网站流量统计报表,甚至要善于分析这些数据指标对网站现阶段及后期阶段的长期影响。

②.网站热图分析

说到网站热力图的概念,相信还是没几个人关注,虽然数据级的跳出率、点击率、页面停留时间直观地反映了用户对单条的偏好页。

但是热图分析有助于我们清楚地了解用户对整个站点上某个主题的偏好。

③.网站日志分析

说到网站日志分析,我们可以从技术角度回顾一个网站,你会清楚地看到你网站上哪些内容不利于长期发展,比如:有有很多死链接,404页面等。

3.网站 的安全措施

目前,我认为 网站 安全方法是我们运营 SEO 增长路径中的障碍或绊脚石。我们相信每一位SEO人员都会遇到这样的挫折和烦恼。那么我们需要注意的问题是:

①.网站在长期DDOS攻击中,CPU使用率高达95%,页面加载缓慢、异常、卡顿。

②。网站中的某个页面被百度快照劫持,部分页面可能被恶意添加黑链接和木马。

③.网站优质文章内容重度采集,甚至全站镜像。

④.排名较高的关键词经常被对手恶意操纵。

以上相关问题都是我们工作中的困扰。要想不断进步,做得更好,就需要不断努力,积累相关知识来解决这些问题。

4.继续努力,积极进取

我们想要一种有效的方法来快速摆脱麻烦。我觉得我们应该不断的努力,不断的学习,与同行业的大佬们互动,不断的练习。只有实践,才能有更多的经验,来做SEO。总结经验,才能快速进步。

SEO总结:不管你从事什么行业,都是一样的,每天都会面临各种各样的烦恼。SEO合作伙伴也是如此。在不同的工作环境中会有一些麻烦。这个时候,我们需要冷静的头脑。理清思路,有针对性的解决烦恼,以上是奶茶妹根据以往的SEO经验分享给大家,仅供参考,希望对大家有所帮助!看完这篇文章,如果觉得不错,不妨采集一下,或者发给需要的朋友同事。每天跟着博主为你展示各种SEO经验,打通你的两条血脉!

全网文章 采集(全网文章采集教程,python爬虫的起步阶段进阶教程)

采集交流 • 优采云 发表了文章 • 0 个评论 • 114 次浏览 • 2022-02-16 09:03

全网文章采集。

小鱼算是比较容易上手的了,

小程序码采集:小程序码-网页二维码识别服务平台上面是我自己做的,小程序码采集很简单的。

新浪微博爬虫,也不需要安装小程序插件~用python就可以爬取。

全网文章采集

这个可以把,不过要会sql.python可以操作全文数据,

爬虫,

思源学习机不能超过2500的语言采集,必须是sql,

现在的小程序还需要androidsdk?

微信公众号爬虫。微信小程序的相关api,可以直接获取各个公众号的分享。

以下是hisio同学整理的一些python爬虫入门的教程:

一、python爬虫的起步进阶1.爬虫起步阶段进阶2.爬虫入门阶段进阶3.爬虫进阶大图文爬虫4.爬虫实战进阶5.爬虫面试进阶

二、python爬虫的提高阶段进阶6.python大神,

三、python爬虫的高级阶段进阶7.python开发面试题包括微信公众号公众号提供的各类功能,在api上都提供完整的api接口,可以直接来按要求实现自己的需求,我们用的一些比较方便的api,都写在我们的小程序里面。比如公众号发布的某篇文章,点击进去可以获取分享,扫码可以调用小程序,服务号发送的消息和反馈都可以进行抓取。

想要获取一些数据的话,一般都是可以通过关键词或者数据获取到文章链接的。不过要注意一些大型网站或者是需要爬取的文章比较多,要爬取的话是比较麻烦的,python一般不是太熟练的小伙伴可以考虑微信公众号,或者是爬虫提高阶段再写。还有一些比较方便的,能快速爬取到一些数据的api,这里列出来供大家参考:1.想爬取某个内容,可以在小程序中进行获取,也可以转移到公众号中然后继续获取。

链接地址2.除了微信公众号提供的api,还有专门的关键词搜索,这里的搜索结果也是可以抓取到的。3.其实微信公众号其实就能满足大部分爬虫的需求,而且爬取的效率非常高。

四、小程序的底层能力问答小程序与公众号虽然用起来很像,但是它们采用不同的底层程序,如果使用了公众号的一些api,抓取效率会高很多。爬虫的实际需求是从微信获取公众号,或者是直接在公众号中获取文章分享的链接,如果要抓取到公众号,还需要公众号和小程序同时存在的时候, 查看全部

全网文章 采集(全网文章采集教程,python爬虫的起步阶段进阶教程)

全网文章采集。

小鱼算是比较容易上手的了,

小程序码采集:小程序码-网页二维码识别服务平台上面是我自己做的,小程序码采集很简单的。

新浪微博爬虫,也不需要安装小程序插件~用python就可以爬取。

全网文章采集

这个可以把,不过要会sql.python可以操作全文数据,

爬虫,

思源学习机不能超过2500的语言采集,必须是sql,

现在的小程序还需要androidsdk?

微信公众号爬虫。微信小程序的相关api,可以直接获取各个公众号的分享。

以下是hisio同学整理的一些python爬虫入门的教程:

一、python爬虫的起步进阶1.爬虫起步阶段进阶2.爬虫入门阶段进阶3.爬虫进阶大图文爬虫4.爬虫实战进阶5.爬虫面试进阶

二、python爬虫的提高阶段进阶6.python大神,

三、python爬虫的高级阶段进阶7.python开发面试题包括微信公众号公众号提供的各类功能,在api上都提供完整的api接口,可以直接来按要求实现自己的需求,我们用的一些比较方便的api,都写在我们的小程序里面。比如公众号发布的某篇文章,点击进去可以获取分享,扫码可以调用小程序,服务号发送的消息和反馈都可以进行抓取。

想要获取一些数据的话,一般都是可以通过关键词或者数据获取到文章链接的。不过要注意一些大型网站或者是需要爬取的文章比较多,要爬取的话是比较麻烦的,python一般不是太熟练的小伙伴可以考虑微信公众号,或者是爬虫提高阶段再写。还有一些比较方便的,能快速爬取到一些数据的api,这里列出来供大家参考:1.想爬取某个内容,可以在小程序中进行获取,也可以转移到公众号中然后继续获取。

链接地址2.除了微信公众号提供的api,还有专门的关键词搜索,这里的搜索结果也是可以抓取到的。3.其实微信公众号其实就能满足大部分爬虫的需求,而且爬取的效率非常高。

四、小程序的底层能力问答小程序与公众号虽然用起来很像,但是它们采用不同的底层程序,如果使用了公众号的一些api,抓取效率会高很多。爬虫的实际需求是从微信获取公众号,或者是直接在公众号中获取文章分享的链接,如果要抓取到公众号,还需要公众号和小程序同时存在的时候,

全网文章 采集(全网文章采集工具解决了内容提取、文章转化工具)

采集交流 • 优采云 发表了文章 • 0 个评论 • 99 次浏览 • 2022-02-12 13:00

全网文章采集工具解决了内容提取、文章转化工具,还可以提取链接,搜索文章最新内容,提供长尾关键词、关键词搜索和个性化关键词等。详情可以添加我的微信号免费索取。

采集抖音视频?

可以建议大家几个,可以私聊我,方便日后沟通,

有!我就找了个这样的全网的,

用导航的就可以

在电脑上,打开互动百科网站,我要分享。然后,点搜索。搜索国外的比如这个,还可以搜到一些本地的网站。找到你需要的话题进去查找,

我昨天刚好找到一个freepik网站,目前支持facebook,instagram,twitter,youtube,并且有相关帖子,这个是我自己找到的一个站子,最喜欢的是这个支持中文搜索,还有分享帖。facebook,instagram,twitter都可以去查找自己感兴趣的文章,但目前只支持该站点,如果有其他的网站不妨去查找分享,至于详细的网站介绍和具体使用方法可以去facebook,instagram,twitter等搜索看看。

可以搜索一下"全网平台采集"

找了三家都没有回应,另一家“千”站长网“文案工厂”好像上线时间比较早,还是收费的。

用中文的reeder

freepik网站有中文版

对于全网的内容采集,其实很容易,用processon或者麦库,也可以看这个网站发布出来的内容分类信息。 查看全部

全网文章 采集(全网文章采集工具解决了内容提取、文章转化工具)

全网文章采集工具解决了内容提取、文章转化工具,还可以提取链接,搜索文章最新内容,提供长尾关键词、关键词搜索和个性化关键词等。详情可以添加我的微信号免费索取。

采集抖音视频?

可以建议大家几个,可以私聊我,方便日后沟通,

有!我就找了个这样的全网的,

用导航的就可以

在电脑上,打开互动百科网站,我要分享。然后,点搜索。搜索国外的比如这个,还可以搜到一些本地的网站。找到你需要的话题进去查找,

我昨天刚好找到一个freepik网站,目前支持facebook,instagram,twitter,youtube,并且有相关帖子,这个是我自己找到的一个站子,最喜欢的是这个支持中文搜索,还有分享帖。facebook,instagram,twitter都可以去查找自己感兴趣的文章,但目前只支持该站点,如果有其他的网站不妨去查找分享,至于详细的网站介绍和具体使用方法可以去facebook,instagram,twitter等搜索看看。

可以搜索一下"全网平台采集"

找了三家都没有回应,另一家“千”站长网“文案工厂”好像上线时间比较早,还是收费的。

用中文的reeder

freepik网站有中文版

对于全网的内容采集,其实很容易,用processon或者麦库,也可以看这个网站发布出来的内容分类信息。

全网文章 采集(全网文章采集资料怎么找——百度文库分享链接)

采集交流 • 优采云 发表了文章 • 0 个评论 • 121 次浏览 • 2022-02-05 16:00

全网文章采集非常简单:1.打开我是作者,点击新建采集任务;2.填写采集规则;3.发布任务即可。如图:一键到达全网所有文章采集,支持公众号、图文、音频、视频;同时对于文章可以实现智能筛选、拼接等多种优化方式,一次编辑,多次导出。更多文章采集细节,

公众号的话我并不太了解,但如果是百度一搜索,并且点击相关图片看了文章,基本上就是系列或者直接复制过来的。如果你认为图片可能是别人抠出来的,我只能说各花入各眼,你还不如自己用复制粘贴功能自己去完成呢。这篇文章是别人做过的百度文库分享链接,来自一个非本专业小白的百度百科,你可以参考一下。

分享给大家一篇学习笔记~全网文章采集资料怎么找——分享给大家希望对大家有帮助

通过微信关注百度文库以下地址,即可1。打开百度文库2。长按下图为例将页面上的知道扫一扫二维码即可关注知道微信公众号3。长按识别后,点击微信公众号-微信采集4。出现三个文件夹,这里点击第一个-为了方便采集,您需要选择几篇您需要分享的文档出现几篇也是可以看的,点击这个查看即可是否需要全网文章采集,小编不太清楚5。

分享至微信-点击开始获取笔记报告,大家保存或点击开始获取报告即可,然后分享,小编就收到啦!如果喜欢就点个赞加关注吧。 查看全部

全网文章 采集(全网文章采集资料怎么找——百度文库分享链接)

全网文章采集非常简单:1.打开我是作者,点击新建采集任务;2.填写采集规则;3.发布任务即可。如图:一键到达全网所有文章采集,支持公众号、图文、音频、视频;同时对于文章可以实现智能筛选、拼接等多种优化方式,一次编辑,多次导出。更多文章采集细节,

公众号的话我并不太了解,但如果是百度一搜索,并且点击相关图片看了文章,基本上就是系列或者直接复制过来的。如果你认为图片可能是别人抠出来的,我只能说各花入各眼,你还不如自己用复制粘贴功能自己去完成呢。这篇文章是别人做过的百度文库分享链接,来自一个非本专业小白的百度百科,你可以参考一下。

分享给大家一篇学习笔记~全网文章采集资料怎么找——分享给大家希望对大家有帮助