全网文章采集

阿里妈妈全网站采集,文章采集关键词采集功能

采集交流 • 优采云 发表了文章 • 0 个评论 • 525 次浏览 • 2021-02-16 11:01

全网文章采集功能。文章下载-全网文章采集,网页采集,采集公众号网页,网页内文章链接、导航,网、京东网等平台内容,支持全网搜索。

全网文章采集服务可以去志强云采集那里看看,

阿里妈妈中国站点进行采集,文章搜索引擎收录和排名好一些,此类需要采集数据源网站,直接一键下载百度,搜狗等。收费程度也是要根据你采集的数据量情况决定的。地址:,一般站长可以用来发文章自己做个站,排名在前端,可以引流,或者来个低价低价、天猫等都是有机会的。

阿里妈妈全网站采集,文章采集,关键词采集。

采集阿里妈妈的数据!!你需要seo人才或者谷歌blogger的账号,不是vip也可以采集,优点是有站长协助,比如有很多源站不愿意充vip,放着没生意,所以你注册源站号等他们发布就行。

目前很多创业公司都离不开订阅号与服务号。打开很多app都能看到很多关于创业,销售,生活的信息,平时也很少翻查,现在基本也已经过了信息泛滥的时代,所以现在的订阅号与服务号越来越少了。这里有个智能的工具,快速帮你把大量的用户信息采集出来,然后有针对性做一些推广。

搞竞价,通过竞价网站把想要的网站链接采集下来,

网站数据采集与商品源码抓取数据采集这个真的不是个问题.能搞定一切!!!小项目...当然有的项目要有采集技术,比如秒杀的商品源码. 查看全部

阿里妈妈全网站采集,文章采集关键词采集功能

全网文章采集功能。文章下载-全网文章采集,网页采集,采集公众号网页,网页内文章链接、导航,网、京东网等平台内容,支持全网搜索。

全网文章采集服务可以去志强云采集那里看看,

阿里妈妈中国站点进行采集,文章搜索引擎收录和排名好一些,此类需要采集数据源网站,直接一键下载百度,搜狗等。收费程度也是要根据你采集的数据量情况决定的。地址:,一般站长可以用来发文章自己做个站,排名在前端,可以引流,或者来个低价低价、天猫等都是有机会的。

阿里妈妈全网站采集,文章采集,关键词采集。

采集阿里妈妈的数据!!你需要seo人才或者谷歌blogger的账号,不是vip也可以采集,优点是有站长协助,比如有很多源站不愿意充vip,放着没生意,所以你注册源站号等他们发布就行。

目前很多创业公司都离不开订阅号与服务号。打开很多app都能看到很多关于创业,销售,生活的信息,平时也很少翻查,现在基本也已经过了信息泛滥的时代,所以现在的订阅号与服务号越来越少了。这里有个智能的工具,快速帮你把大量的用户信息采集出来,然后有针对性做一些推广。

搞竞价,通过竞价网站把想要的网站链接采集下来,

网站数据采集与商品源码抓取数据采集这个真的不是个问题.能搞定一切!!!小项目...当然有的项目要有采集技术,比如秒杀的商品源码.

干货教程:爆款文章怎么搜集?看完这篇文章就懂了!

采集交流 • 优采云 发表了文章 • 0 个评论 • 243 次浏览 • 2020-12-24 08:10

在流行期间,许多公司不得不选择远程在线办公室。互联网是受流行病影响较小的行业之一。但是,远程办公室的效率仍然不如面对面的工作。因此,优采云采集特别推出了智能采集工具。

我相信许多操作员已经接触过采集工具。市场上有很多采集工具。许多人认为采集工具仅用作文章热门/节日主题和其他信息采集的辅助工具,实际上,不仅如此。成熟的采集工具不仅可以帮助操作采集信息,而且可以准确地分析数据趋势,从而有助于增加收入。

一、什么是优采云采集?

优采云采集是用于自媒体素材搜索,文章 原创一键式发布的操作工具,可有效提高新媒体运营的效率并降低公司成本。

二、如何用优采云采集搜索?

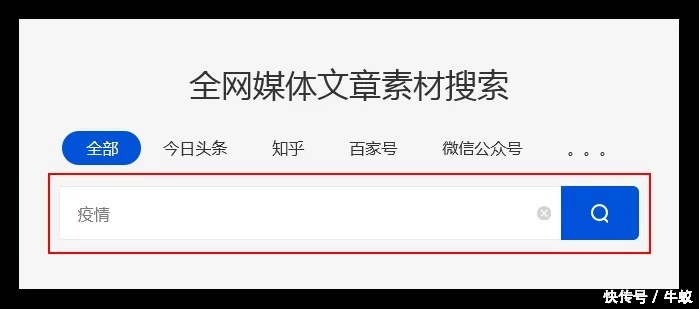

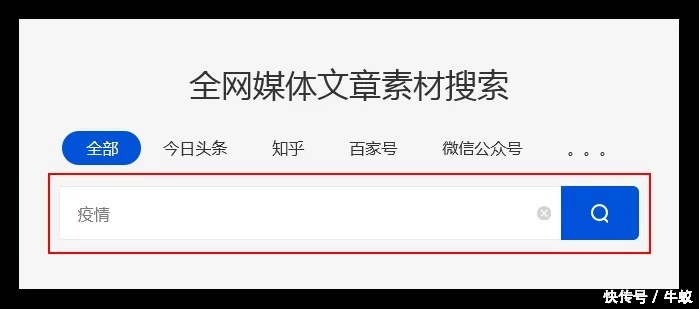

([一)输入关键词

优采云采集根据用户输入的关键词,搜索引擎会通过程序自动输入主流自媒体数据源进行搜索。

优采云采集基于高级算法匹配更准确的内容,以提高搜索内容的准确性。

例如:

用户需要采集与流行病有关的资料,并在主页上输入关键词“流行病”。 优采云采集会将搜索结果合并到一个列表中。

广告设备取决于刷牙!传奇手游的副本版本,散落的人们再次联手,与怪物战斗!

广告传奇一旦上线,将立即流行起来!值得成都在5D生产上进行巨额投资,其爆炸速度为+9999亿!

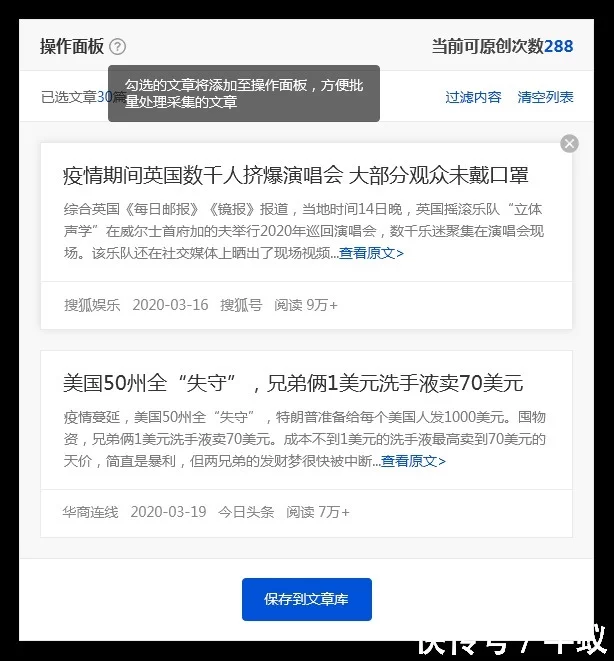

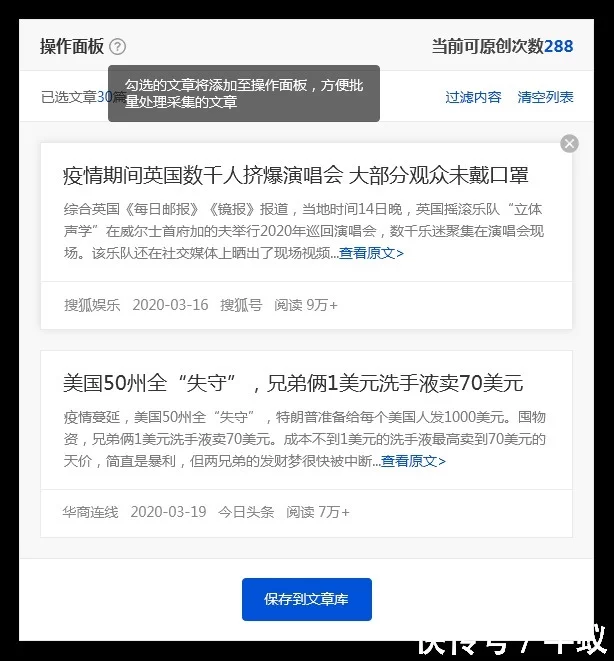

([二)保存搜索材料

优采云采集具有批量保存搜索资料的功能。

单击[在当前页上全部选择]功能,然后选中所需的文章,文章将添加到操作面板中,方便用户批量保存。

广告残茬增长很快?试试这款剃须刀,剃须后不会留下任何残留物,随身携带非常方便,免费送货

广告[震惊]德国取暖器,在3秒钟内迅速升温,整个房间都很温暖! 3天1千瓦小时!

([三)精确过滤

1、搜索过滤器

优采云采集支持根据标题,内容,时间,平台,是否为原创等参数进行过滤,以使搜索内容更加准确。

广告宣传高爆炸性传奇人物会挑出所有头目,在几秒钟内爆出9999武器

2、广告过滤 查看全部

干货教程:爆款文章怎么搜集?看完这篇文章就懂了!

在流行期间,许多公司不得不选择远程在线办公室。互联网是受流行病影响较小的行业之一。但是,远程办公室的效率仍然不如面对面的工作。因此,优采云采集特别推出了智能采集工具。

我相信许多操作员已经接触过采集工具。市场上有很多采集工具。许多人认为采集工具仅用作文章热门/节日主题和其他信息采集的辅助工具,实际上,不仅如此。成熟的采集工具不仅可以帮助操作采集信息,而且可以准确地分析数据趋势,从而有助于增加收入。

一、什么是优采云采集?

优采云采集是用于自媒体素材搜索,文章 原创一键式发布的操作工具,可有效提高新媒体运营的效率并降低公司成本。

二、如何用优采云采集搜索?

([一)输入关键词

优采云采集根据用户输入的关键词,搜索引擎会通过程序自动输入主流自媒体数据源进行搜索。

优采云采集基于高级算法匹配更准确的内容,以提高搜索内容的准确性。

例如:

用户需要采集与流行病有关的资料,并在主页上输入关键词“流行病”。 优采云采集会将搜索结果合并到一个列表中。

广告设备取决于刷牙!传奇手游的副本版本,散落的人们再次联手,与怪物战斗!

广告传奇一旦上线,将立即流行起来!值得成都在5D生产上进行巨额投资,其爆炸速度为+9999亿!

([二)保存搜索材料

优采云采集具有批量保存搜索资料的功能。

单击[在当前页上全部选择]功能,然后选中所需的文章,文章将添加到操作面板中,方便用户批量保存。

广告残茬增长很快?试试这款剃须刀,剃须后不会留下任何残留物,随身携带非常方便,免费送货

广告[震惊]德国取暖器,在3秒钟内迅速升温,整个房间都很温暖! 3天1千瓦小时!

([三)精确过滤

1、搜索过滤器

优采云采集支持根据标题,内容,时间,平台,是否为原创等参数进行过滤,以使搜索内容更加准确。

广告宣传高爆炸性传奇人物会挑出所有头目,在几秒钟内爆出9999武器

2、广告过滤

事实:多种自媒体文章采集平台的强大功能

采集交流 • 优采云 发表了文章 • 0 个评论 • 313 次浏览 • 2020-12-12 13:22

自媒体文章采集平台的力量

智能采集,提供各种网页采集策略和支持资源,以帮助整个采集流程实现数据完整性和稳定性。 Tuotu Data的工作人员告诉您,它适用于整个网络,无论是文字图片还是贴吧论坛,都可以即时采集。它支持所有业务渠道的采集器,以满足各种采集需求,大量模板以及数百个内置A网站数据源,全面覆盖多个行业,只需简单的设置,即可快速而准确地获取数据。简单易用,无需学习爬虫编程技术,只需三个简单的步骤即可轻松获取Web数据,支持多种格式的一键导出,并快速导入数据库。稳定高效,由分布式云服务器和多用户协作管理平台支持,它可以灵活地调度任务并平滑地爬行海量数据。

自媒体文章采集平台

新手不能写文章,我该怎么办?

自媒体的许多新手都有常见问题。他们不知道如何写标题,如何减少热点等。我想找一个人学习,但是我发现我所能找到的只是与我基本处于同一水平的人,因为那些人非常愿意花时间与小白进行交流,而与小白进行交流对他们有好处。没有利益,我自己的事情也没来,小白总是想找一个懂得并且干得很好的人来带领他,却忘记了他为什么是小白,而其他人却花时间带领你。您不能给这些人带来任何好处。其他人则导致您浪费时间。如果您有这段时间,其他人可以通过写一篇文章文章来赚更多的钱。

自媒体文章采集平台

除了以上Tuotu Data员工介绍的功能外,还有更多图片材料功能和更多根据您需要的功能。

本文介绍并详细解释了自媒体文章采集平台的强大功能和类型。我希望对这方面有兴趣的朋友可以参考并希望对您有所帮助。

更多信息和知识点将继续受到关注。后续活动将是自媒体咖啡馆爆文采集平台,自媒体文章采集平台,公共帐户查询,重印他人的原创文章,公共帐户历史记录文章和其他知识点。 查看全部

平台的自媒体文章采集个强大功能

自媒体文章采集平台的力量

智能采集,提供各种网页采集策略和支持资源,以帮助整个采集流程实现数据完整性和稳定性。 Tuotu Data的工作人员告诉您,它适用于整个网络,无论是文字图片还是贴吧论坛,都可以即时采集。它支持所有业务渠道的采集器,以满足各种采集需求,大量模板以及数百个内置A网站数据源,全面覆盖多个行业,只需简单的设置,即可快速而准确地获取数据。简单易用,无需学习爬虫编程技术,只需三个简单的步骤即可轻松获取Web数据,支持多种格式的一键导出,并快速导入数据库。稳定高效,由分布式云服务器和多用户协作管理平台支持,它可以灵活地调度任务并平滑地爬行海量数据。

自媒体文章采集平台

新手不能写文章,我该怎么办?

自媒体的许多新手都有常见问题。他们不知道如何写标题,如何减少热点等。我想找一个人学习,但是我发现我所能找到的只是与我基本处于同一水平的人,因为那些人非常愿意花时间与小白进行交流,而与小白进行交流对他们有好处。没有利益,我自己的事情也没来,小白总是想找一个懂得并且干得很好的人来带领他,却忘记了他为什么是小白,而其他人却花时间带领你。您不能给这些人带来任何好处。其他人则导致您浪费时间。如果您有这段时间,其他人可以通过写一篇文章文章来赚更多的钱。

自媒体文章采集平台

除了以上Tuotu Data员工介绍的功能外,还有更多图片材料功能和更多根据您需要的功能。

本文介绍并详细解释了自媒体文章采集平台的强大功能和类型。我希望对这方面有兴趣的朋友可以参考并希望对您有所帮助。

更多信息和知识点将继续受到关注。后续活动将是自媒体咖啡馆爆文采集平台,自媒体文章采集平台,公共帐户查询,重印他人的原创文章,公共帐户历史记录文章和其他知识点。

解决方案:SWrite互链文档:一款能够把外部信息也链起来的双向链产品;链接全网信息

采集交流 • 优采云 发表了文章 • 0 个评论 • 302 次浏览 • 2020-11-16 08:00

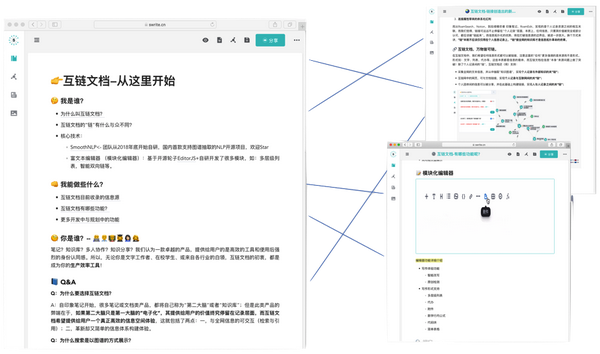

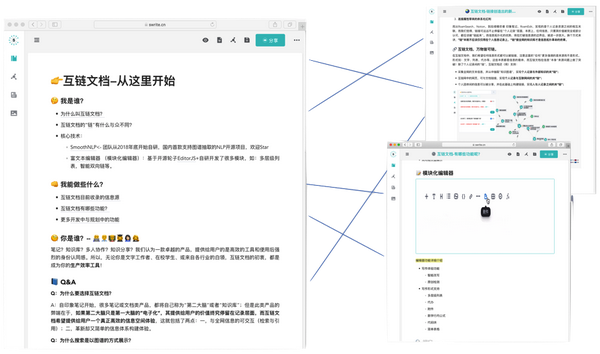

最近在许多笔记产品中引入的双向链接功能来自一个非常简单的想法:“在两个文章文章中添加链接关系”;但是这种简单的功能很快席卷了许多知识社区。

对于许多作者而言,双向链接功能不同于传统的文件夹系统。它轻松地振兴了他们多年积累的历史资料,并帮助他们发现了不容易发现的资料之间的微妙关系,从而立即激发了更多创造性的灵感和想法。

RoamResearch是双向链的公认发起者。在双向链的概念流行之后,一些概念相似的产品在国内外出现了一段时间。但是,无论哪种产品实现功能,仅是个人笔记之间的信息关联。

我们认为双向链不仅应该停留在“个人记录”级别,而且任何有价值的信息都应该“链”在一起。这些外部信息的关联将帮助用户摆脱自己的认知范围,并将有限的个人信息扩展到整个网络的信息中。因此,“链”不仅应用于记录,而且连接整个网络的知识库的“链”是信息拓扑革命的最后一章。这也是我们的Swrite链间文档的核心价值。

相互链接的文档-一切都可以链接

在相互链接的文档中,我们希望可以链接任何信息表格。请注意,此处的“ any”更多地强调源而不是形式。形式,例如:文本,列表,代理等,这些实质上是信息的载体,而互连文档在信息源本身的问题上取得了突破!除了个人记录之间的“链”之外,相互链接的文档还支持:

这种互连所有事物的形式也是我们认为的信息整理和归纳的最终形式。在链接的文档中,只需粘贴外部URL即可构建信息链。

链接的文档-不仅可以记录,而且可以浏览

先生。卡片编写专家王书义提到,卡片记录的重要部分是基于自然语言处理技术的自动链接分析。

在互连文档中,我们将这种想法付诸实践。

输入您感兴趣的知识点,在主页上搜索,然后可以通过链接文档搜索与整个网络相关的信息链(包括您自己记录的信息)。在左侧,外部信息源也将以卡片的形式显示,并且可以根据需要过滤不同的信息源,例如(个人记录文章,外部知识库,信息网页的URL等。 )

摘要:

许多笔记或文件产品将自己称为“第二大脑”或“知识基础”。但是,如果第二大脑只是第一大脑的“电子”,那么它为用户提供的价值最终将保持在记录水平,而与SWrite关联的文档希望为用户提供真正有效的信息空间体验。

请参阅此处,如果您对链接的文档感兴趣,请单击下面的链接参加我们的公开测试:或登录并输入公开测试代码:G318IM

写v0.3.8:链接创造了一个新世界。

查看全部

写链间文档:可以链接外部信息的双向链产品;链接整个网络信息

最近在许多笔记产品中引入的双向链接功能来自一个非常简单的想法:“在两个文章文章中添加链接关系”;但是这种简单的功能很快席卷了许多知识社区。

对于许多作者而言,双向链接功能不同于传统的文件夹系统。它轻松地振兴了他们多年积累的历史资料,并帮助他们发现了不容易发现的资料之间的微妙关系,从而立即激发了更多创造性的灵感和想法。

RoamResearch是双向链的公认发起者。在双向链的概念流行之后,一些概念相似的产品在国内外出现了一段时间。但是,无论哪种产品实现功能,仅是个人笔记之间的信息关联。

我们认为双向链不仅应该停留在“个人记录”级别,而且任何有价值的信息都应该“链”在一起。这些外部信息的关联将帮助用户摆脱自己的认知范围,并将有限的个人信息扩展到整个网络的信息中。因此,“链”不仅应用于记录,而且连接整个网络的知识库的“链”是信息拓扑革命的最后一章。这也是我们的Swrite链间文档的核心价值。

相互链接的文档-一切都可以链接

在相互链接的文档中,我们希望可以链接任何信息表格。请注意,此处的“ any”更多地强调源而不是形式。形式,例如:文本,列表,代理等,这些实质上是信息的载体,而互连文档在信息源本身的问题上取得了突破!除了个人记录之间的“链”之外,相互链接的文档还支持:

这种互连所有事物的形式也是我们认为的信息整理和归纳的最终形式。在链接的文档中,只需粘贴外部URL即可构建信息链。

链接的文档-不仅可以记录,而且可以浏览

先生。卡片编写专家王书义提到,卡片记录的重要部分是基于自然语言处理技术的自动链接分析。

在互连文档中,我们将这种想法付诸实践。

输入您感兴趣的知识点,在主页上搜索,然后可以通过链接文档搜索与整个网络相关的信息链(包括您自己记录的信息)。在左侧,外部信息源也将以卡片的形式显示,并且可以根据需要过滤不同的信息源,例如(个人记录文章,外部知识库,信息网页的URL等。 )

摘要:

许多笔记或文件产品将自己称为“第二大脑”或“知识基础”。但是,如果第二大脑只是第一大脑的“电子”,那么它为用户提供的价值最终将保持在记录水平,而与SWrite关联的文档希望为用户提供真正有效的信息空间体验。

请参阅此处,如果您对链接的文档感兴趣,请单击下面的链接参加我们的公开测试:或登录并输入公开测试代码:G318IM

写v0.3.8:链接创造了一个新世界。

总结:厉害了!实战爬取全网5000部手机|上篇

采集交流 • 优采云 发表了文章 • 0 个评论 • 208 次浏览 • 2020-09-04 20:42

我相信每个人都需要购买手机,那么互联网上有多少个手机品牌?哪款手机具有最高的性价比,最高的评级,最大的屏幕,最好的硬件等,我们都想知道。最好自己爬下整个手机网络,然后慢慢学习。至少在购买手机时可以参考。 文章结合了爬虫,代理和数据库的多种知识,这非常好。

环境:Python 3. 5

使用的库:操作系统,重新,随机,时间,sqlite3,请求,BeautifulSoup,泡菜

使用的工具:Pycharm

1. 网站分析

在这里,我们正在爬中关村在线网站。我们必须首先仔细分析目标网站,以确定要使用的技术:

网页1:手机信息简介页面

1141273是此红色框中的电话ID

页面2:手机概述介绍页面

随意选择手机的连接,然后进入其概述页面

在此页面上,我想获取手机的名称和品牌,以及几种价格(请参阅报价和商人报价),还希望获取图片,参数和评论页面的网址

从以上三张图片可以看出,图片的url结构,参数和查看页面都需要获取1167243(手机ID)之前的数字字符串(pre-id)。第3页:手机参数页面

从图中可以看出,电话具有九个属性(基本参数,屏幕,网络...),大属性对应于几个小属性,小属性对应于特定的内容。我希望在抓取该页面时,构造一个大型的属性字典

attrs = {'基本属性':{'上市时间':'','移动类型':''),}网页4:移动评论页面

在评论页面上,获取评论者的数量,平均分数和详细分数,好坏块2.程序框架

对于代码,我们可以使用Py2或Py 3.,因为使用的库都是py2和py3,让我们看一下整个框架图:

1.手机类别

由于采集的手机信息太多,从手机的价格,品牌,参数,屏幕,网络,硬件,摄像头,服务支持,评估等方面,不止采集有十几种信息,所以将其封装到类中是一种更好的方法

self.attribute是一个大字典,字典设置字典的数据结构

2.数据库类

数据库存储了超过4900部手机的所有信息。为了方便查询和处理,我们设计了12个独立的表,但每个表都以手机ID为键,因此联合查询也非常方便。

查看代码。实际上,该代码类似于我们之前介绍的sqlite3教程

由于数据库的介绍,尤其是SQL语法,我们讨论了很多,因此在这里不再一一赘述。如果您有兴趣,可以看看历史文章(数据库介绍系列文章),以下是基本的手机信息表和得分表两个表

我们从网页中检索数据并将其存储在数据库中。所有数据都是从mobilePhoneList获得的,该列表存储了每部手机的信息。

查看12个表中的电话表:

总共有4921部手机,我突然发现仍然有许多老牌手机仍具有网站的销售结论:

需要源代码的学生,请留言 查看全部

太棒了!在实战中在网络上爬行5000部手机|第1部分

我相信每个人都需要购买手机,那么互联网上有多少个手机品牌?哪款手机具有最高的性价比,最高的评级,最大的屏幕,最好的硬件等,我们都想知道。最好自己爬下整个手机网络,然后慢慢学习。至少在购买手机时可以参考。 文章结合了爬虫,代理和数据库的多种知识,这非常好。

环境:Python 3. 5

使用的库:操作系统,重新,随机,时间,sqlite3,请求,BeautifulSoup,泡菜

使用的工具:Pycharm

1. 网站分析

在这里,我们正在爬中关村在线网站。我们必须首先仔细分析目标网站,以确定要使用的技术:

网页1:手机信息简介页面

1141273是此红色框中的电话ID

页面2:手机概述介绍页面

随意选择手机的连接,然后进入其概述页面

在此页面上,我想获取手机的名称和品牌,以及几种价格(请参阅报价和商人报价),还希望获取图片,参数和评论页面的网址

从以上三张图片可以看出,图片的url结构,参数和查看页面都需要获取1167243(手机ID)之前的数字字符串(pre-id)。第3页:手机参数页面

从图中可以看出,电话具有九个属性(基本参数,屏幕,网络...),大属性对应于几个小属性,小属性对应于特定的内容。我希望在抓取该页面时,构造一个大型的属性字典

attrs = {'基本属性':{'上市时间':'','移动类型':''),}网页4:移动评论页面

在评论页面上,获取评论者的数量,平均分数和详细分数,好坏块2.程序框架

对于代码,我们可以使用Py2或Py 3.,因为使用的库都是py2和py3,让我们看一下整个框架图:

1.手机类别

由于采集的手机信息太多,从手机的价格,品牌,参数,屏幕,网络,硬件,摄像头,服务支持,评估等方面,不止采集有十几种信息,所以将其封装到类中是一种更好的方法

self.attribute是一个大字典,字典设置字典的数据结构

2.数据库类

数据库存储了超过4900部手机的所有信息。为了方便查询和处理,我们设计了12个独立的表,但每个表都以手机ID为键,因此联合查询也非常方便。

查看代码。实际上,该代码类似于我们之前介绍的sqlite3教程

由于数据库的介绍,尤其是SQL语法,我们讨论了很多,因此在这里不再一一赘述。如果您有兴趣,可以看看历史文章(数据库介绍系列文章),以下是基本的手机信息表和得分表两个表

我们从网页中检索数据并将其存储在数据库中。所有数据都是从mobilePhoneList获得的,该列表存储了每部手机的信息。

查看12个表中的电话表:

总共有4921部手机,我突然发现仍然有许多老牌手机仍具有网站的销售结论:

需要源代码的学生,请留言

解决方案:自媒体发布工具,3-5分钟把内容发布全平台

采集交流 • 优采云 发表了文章 • 0 个评论 • 224 次浏览 • 2020-09-02 18:16

自媒体发布工具,需要3-5分钟才能在整个平台上发布内容,自媒体发布工具,我相信很多从事自媒体操作的朋友都会遇到这样的困扰,自媒体发布工具,在创建了内容之后完成后,浪费时间发布. 两到三个帐户可能仍然很忙. 如果有数十到数百个帐户,则每天切换和发布消息将花费超过半天的时间.

至于为什么我们必须同时经营多个账户,我们都知道原因,例如,这与收入直接相关. 如果一个帐户一个月能赚500元,那么10个帐户的收入就是5,000元. 帐户平台越多,我们的帐户收入就越多.

使用“亦庄素材批采集”工具批处理采集 文章视频素材,为您提供写作灵感.

但是,这么多帐户也会引起麻烦,即难以管理和发布. 那么,有没有什么工具可以帮助我们进行帐户管理和发布?不用担心,今天我将为所有人(易小二)共享一个工具. 该工具可以完美解决您当前遇到的问题,并且可以实现跨平台的帐户管理和消息的一键式同步. 让我向您介绍该工具的详细功能.

1. 管理分配:

同时管理200+ 自媒体个帐户. 发布内容仅需3-5分钟,并且可以定期将其发送到30+ 自媒体平台.

2. 帐户组管理:

要满足垂直细分中内容创建者的需求,请使用分组来划分平台帐户.

3. 支持数据自动报告:

您可以在employee 自媒体平台上查看详细数据,以便更好地管理员工并快速了解文章的状态.

4. 团队权限管理

可以根据不同的操作员划分不同的帐户和不同的权限,以方便管理人员过帐数据.

其次,让我们看一下如何使用此工具:

1. 发行文章:

导入文章,登录平台帐户后,单击[发送文章],您可以选择导入单词或链接,也可以直接编写要在编辑器中发布的内容.

易小儿支持编辑器排版和一键式预览功能.

写入文章后,单击[一键分发],选择要发布的平台,单击“启用”,或直接在该帐户中选择需要分发的帐户;如果不需要使用下一篇文章文章,则对于某个平台或帐户,请记住返回发布平台设置,并取消选中以启用或删除相关帐户.

请记住仅在登录时检查! 文章如果您不需要临时发布,则可以选择[保存在草稿箱中]

检查帐户后,根据每个平台的权限填写相应的信息,最后单击“发布”.

输入[发送视频],单击[添加本地视频],单击[单击发布],然后选择要发布的相应帐户.

请注意视频的格式! 查看全部

自媒体发布工具,需要3-5分钟才能在所有平台上发布内容

自媒体发布工具,需要3-5分钟才能在整个平台上发布内容,自媒体发布工具,我相信很多从事自媒体操作的朋友都会遇到这样的困扰,自媒体发布工具,在创建了内容之后完成后,浪费时间发布. 两到三个帐户可能仍然很忙. 如果有数十到数百个帐户,则每天切换和发布消息将花费超过半天的时间.

至于为什么我们必须同时经营多个账户,我们都知道原因,例如,这与收入直接相关. 如果一个帐户一个月能赚500元,那么10个帐户的收入就是5,000元. 帐户平台越多,我们的帐户收入就越多.

使用“亦庄素材批采集”工具批处理采集 文章视频素材,为您提供写作灵感.

但是,这么多帐户也会引起麻烦,即难以管理和发布. 那么,有没有什么工具可以帮助我们进行帐户管理和发布?不用担心,今天我将为所有人(易小二)共享一个工具. 该工具可以完美解决您当前遇到的问题,并且可以实现跨平台的帐户管理和消息的一键式同步. 让我向您介绍该工具的详细功能.

1. 管理分配:

同时管理200+ 自媒体个帐户. 发布内容仅需3-5分钟,并且可以定期将其发送到30+ 自媒体平台.

2. 帐户组管理:

要满足垂直细分中内容创建者的需求,请使用分组来划分平台帐户.

3. 支持数据自动报告:

您可以在employee 自媒体平台上查看详细数据,以便更好地管理员工并快速了解文章的状态.

4. 团队权限管理

可以根据不同的操作员划分不同的帐户和不同的权限,以方便管理人员过帐数据.

其次,让我们看一下如何使用此工具:

1. 发行文章:

导入文章,登录平台帐户后,单击[发送文章],您可以选择导入单词或链接,也可以直接编写要在编辑器中发布的内容.

易小儿支持编辑器排版和一键式预览功能.

写入文章后,单击[一键分发],选择要发布的平台,单击“启用”,或直接在该帐户中选择需要分发的帐户;如果不需要使用下一篇文章文章,则对于某个平台或帐户,请记住返回发布平台设置,并取消选中以启用或删除相关帐户.

请记住仅在登录时检查! 文章如果您不需要临时发布,则可以选择[保存在草稿箱中]

检查帐户后,根据每个平台的权限填写相应的信息,最后单击“发布”.

输入[发送视频],单击[添加本地视频],单击[单击发布],然后选择要发布的相应帐户.

请注意视频的格式!

解决方案:优质全网营销型网站制作行情

采集交流 • 优采云 发表了文章 • 0 个评论 • 180 次浏览 • 2020-08-29 10:46

靖江百度爱采购服务保障

一、 什么是模板站点?

模板网站是由多家网路公司开发的一整套成形网站。根据顾客的喜好选择已产生的网站模板,并修改图片文本和公司徽标。模板网站提供商不向顾客提供源文件,除非另外收费,否则网站功能扩充也十分困难。可能有几十家甚至上百家公司同时使用同一模板,导致大量网站一模一样,没有功能,搜索引擎未能收录,网站安全也得不到保障。

(1) 模板站点有哪些益处?

采集过多文章或者伪原创文章,都容易被搜索引擎评定为低质网站。文章都以前被其它网站发布过,搜索引擎能够辨识下来加以剖析,就晓得文章的原创度高低。只要站显存在太多低原创的文章,就会减少对网站的友好度,也会影响抓取和收录,有的网站优化了很长时间都没疗效,原因就在这里。因此,企业在选择内容和上传的时侯要把控好内容质量,尽量以原创为主。

1、制作时间短:模板网站是一个成形的网站,所以模板提供网路公司不需要花费大量的人力物力,只须要更改文字和图片就可以节约顾客时间。对于一些只须要一个网站的顾客,他们可以选择节约时间。

2、购买成本低:一般模板网站的价钱在1000-2000之间,甚至有几百元的模板网站。对于一些不乐意耗费成本的顾客,模板是您的。然而,俗话说,“一分钱一货”。如果实惠,就不好。这里省略1000字。

3、有的顾客申请:对于一些只须要一个网站的顾客,模板网站是您的选择,但倘若您希望网站为公司起到一定的宣传、营销和业务拓展作用,模板网站将不会起到任何作用。

(二)模板网站的缺点是哪些?

模板建设是网站建设价钱低廉的主要诱因,因为借助网站模板来建网站时,需要设计网站架构方面的东西极少,只须要找同行业的网站模板进行文字和图片的更改和应用。所以,模板建站的时间相对太短,很快能够建设出一个网站了。网站兼容性的考虑也是网站建设中的一个重要过程,如果只有个别浏览器才会打开网站,而其他浏览器却不能打开网站或者网站的页面出现长短不齐,可能直接影响网站的后期营运

1、功能可扩展性差:一般来说,2、主页和页面标题的编撰方式:要快速提升权重,保证权重不分散,需要做好集中。首先,你须要从标题开始。如果你的标题只有一个关键字,那么关键字的权重就很高。模板网站的框架结构是固定的,功能可扩展性几乎是不可能的。对于所选模板,用户不能独立随机编辑,更不能导出自定义模板。这种共享技术所设计的页面常常是迂腐的、一模一样的,很难被接受。网站内容该如何设计,该如何布局这种都是很重要的,这直接影响到用户对企业的***直观印象。还有内容的正确性也是企业要注意的,有些不专业的企业英语网站你会发觉好多中文内容是错误的,结果可想而知,***基本的信息内容都是错的,对企业自身的印象也是不好的,还有网站字体以及图片都要符合用户群体的须要,这些我们可以参考一些外国网站,英文网站的字体通常比较小,图片只要简单大方就行。

2、不利于搜索引擎:模板网站代码相同,结构相同,搜索引擎能有效辨识模板网站的程序,并给它相应的低分,加上自身的关键词,网站内容维护不及时等,通过搜索几乎不可能达到推广目的。

3、就像两粒蚕豆一样,没有源文件:模板网站不会开发源文件给顾客网站。你觉得,网络公司早已开发了数百个模板销售。如果你提供源文件,那么公司会向其他顾客选购哪些?很多客户就会频繁地作出反应。为什么我的网站和其他网站一模一样?能够清晰地向用户传递正确的信息,包括告诉用户你是什么样的企业,你主要生产什么样的产品。你也可以在左边写下企业的联系方法,以显示企业的实力。这是因为你使用的模板也被其他顾客使用,缺乏个性。无法达到公司原先期望的疗效。

4、后期续费高:模板网站后期续费普遍偏低,原因何在?网络公司要想生存下去,就必须有业务和顾客。顾客如何来?很多网路公司常常捉住了好多贪恋实惠的顾客的心理。在初期阶段,他们以优价吸引顾客使用她们的模板网站,然后在之后填补差额。很多事情都是有限制的。将来,他们说多少就是多少。客户没有自主权,除非你不想要这个网站,然后再花钱构建一个网站。这样,公司的成本、人力物力也都下来了。***终的结果是网站没有自主权,空间没有自主权,域名也没有自主权。它还是空的。为什么? 查看全部

优质全网营销型网站制作行情

靖江百度爱采购服务保障

一、 什么是模板站点?

模板网站是由多家网路公司开发的一整套成形网站。根据顾客的喜好选择已产生的网站模板,并修改图片文本和公司徽标。模板网站提供商不向顾客提供源文件,除非另外收费,否则网站功能扩充也十分困难。可能有几十家甚至上百家公司同时使用同一模板,导致大量网站一模一样,没有功能,搜索引擎未能收录,网站安全也得不到保障。

(1) 模板站点有哪些益处?

采集过多文章或者伪原创文章,都容易被搜索引擎评定为低质网站。文章都以前被其它网站发布过,搜索引擎能够辨识下来加以剖析,就晓得文章的原创度高低。只要站显存在太多低原创的文章,就会减少对网站的友好度,也会影响抓取和收录,有的网站优化了很长时间都没疗效,原因就在这里。因此,企业在选择内容和上传的时侯要把控好内容质量,尽量以原创为主。

1、制作时间短:模板网站是一个成形的网站,所以模板提供网路公司不需要花费大量的人力物力,只须要更改文字和图片就可以节约顾客时间。对于一些只须要一个网站的顾客,他们可以选择节约时间。

2、购买成本低:一般模板网站的价钱在1000-2000之间,甚至有几百元的模板网站。对于一些不乐意耗费成本的顾客,模板是您的。然而,俗话说,“一分钱一货”。如果实惠,就不好。这里省略1000字。

3、有的顾客申请:对于一些只须要一个网站的顾客,模板网站是您的选择,但倘若您希望网站为公司起到一定的宣传、营销和业务拓展作用,模板网站将不会起到任何作用。

(二)模板网站的缺点是哪些?

模板建设是网站建设价钱低廉的主要诱因,因为借助网站模板来建网站时,需要设计网站架构方面的东西极少,只须要找同行业的网站模板进行文字和图片的更改和应用。所以,模板建站的时间相对太短,很快能够建设出一个网站了。网站兼容性的考虑也是网站建设中的一个重要过程,如果只有个别浏览器才会打开网站,而其他浏览器却不能打开网站或者网站的页面出现长短不齐,可能直接影响网站的后期营运

1、功能可扩展性差:一般来说,2、主页和页面标题的编撰方式:要快速提升权重,保证权重不分散,需要做好集中。首先,你须要从标题开始。如果你的标题只有一个关键字,那么关键字的权重就很高。模板网站的框架结构是固定的,功能可扩展性几乎是不可能的。对于所选模板,用户不能独立随机编辑,更不能导出自定义模板。这种共享技术所设计的页面常常是迂腐的、一模一样的,很难被接受。网站内容该如何设计,该如何布局这种都是很重要的,这直接影响到用户对企业的***直观印象。还有内容的正确性也是企业要注意的,有些不专业的企业英语网站你会发觉好多中文内容是错误的,结果可想而知,***基本的信息内容都是错的,对企业自身的印象也是不好的,还有网站字体以及图片都要符合用户群体的须要,这些我们可以参考一些外国网站,英文网站的字体通常比较小,图片只要简单大方就行。

2、不利于搜索引擎:模板网站代码相同,结构相同,搜索引擎能有效辨识模板网站的程序,并给它相应的低分,加上自身的关键词,网站内容维护不及时等,通过搜索几乎不可能达到推广目的。

3、就像两粒蚕豆一样,没有源文件:模板网站不会开发源文件给顾客网站。你觉得,网络公司早已开发了数百个模板销售。如果你提供源文件,那么公司会向其他顾客选购哪些?很多客户就会频繁地作出反应。为什么我的网站和其他网站一模一样?能够清晰地向用户传递正确的信息,包括告诉用户你是什么样的企业,你主要生产什么样的产品。你也可以在左边写下企业的联系方法,以显示企业的实力。这是因为你使用的模板也被其他顾客使用,缺乏个性。无法达到公司原先期望的疗效。

4、后期续费高:模板网站后期续费普遍偏低,原因何在?网络公司要想生存下去,就必须有业务和顾客。顾客如何来?很多网路公司常常捉住了好多贪恋实惠的顾客的心理。在初期阶段,他们以优价吸引顾客使用她们的模板网站,然后在之后填补差额。很多事情都是有限制的。将来,他们说多少就是多少。客户没有自主权,除非你不想要这个网站,然后再花钱构建一个网站。这样,公司的成本、人力物力也都下来了。***终的结果是网站没有自主权,空间没有自主权,域名也没有自主权。它还是空的。为什么?

如何从互联网采集海量数据?租房,二手房,薪酬……

采集交流 • 优采云 发表了文章 • 0 个评论 • 338 次浏览 • 2020-08-26 00:12

作者:沙漠君

不少同学看了沙漠君的文章后,都会问:那几十万条租房,二手房,薪酬,乃至天气数据都是从那里来的?其实我还没告诉你这种数据在十几分钟内就可以采集到!

一般我会回答,我用专门的工具,无需编程也能快速抓取。之后肯定又会被问,在那里能下载这个工具呢?

我淡淡的说,我自己写的。。。(这个B装的...我给95分!)

沙漠君近来比较忙乱,说好的一大堆写作任务都还没有完成。

授人以虾不如授人以渔,我做了一个决定,将这套软件全部开源到GitHub !

免费使用,开放源代码! 从此以后,估计好多做爬虫的工程师要待业了。。。因为我的目标是使普通人也能使用!!!目标有点远大,不过其实距离不远了(不到一光年吧)。

这篇文章介绍爬虫大约的原理,文末会有程序地址。

什么是爬虫?

互联网是一张大网,采集数据的小程序可以形象地称之为爬虫或则蜘蛛。

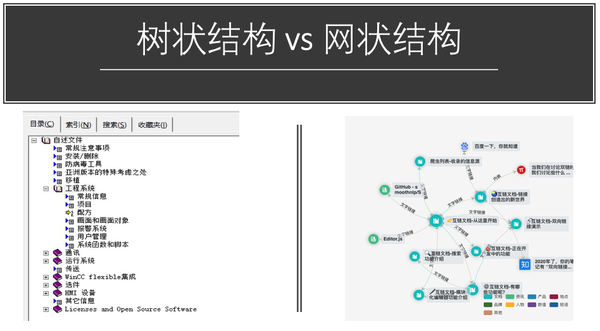

爬虫的原理很简单,我们在访问网页时,会点击翻页按键和超链接,浏览器会帮我们恳请所有的资源和图片。所以,你可以设计一个程序,能够模拟人在浏览器上的操作,让网站误觉得爬虫是正常访问者,它还会把所需的数据乖乖送回去。

爬虫分为两种,一种象百度(黑)那样哪些都抓的搜索引擎爬虫。另一种就是沙漠君开发的,只精确地抓取所需的内容:比如我只要二手房信息,旁边的广告和新闻一律不要。

爬虫这样的名子并不好听,所以我给这套软件取名为Hawk,指代为"鹰",能够精确,快速地捕捉猎物。 基本不需编程,通过图形化拖放的操作来快速设计爬虫,有点像Photoshop。它能在20分钟内编撰大众点评的爬虫(简化版只需3分钟),然后使它运行就好啦

自动将网页导入为Excel

那么,一个页面这么大,爬虫如何晓得我想要哪些呢?

人其实可以很容易地看出,上图的红框是二手房信息,但机器不知道。

网页是一种有结构的树,而重要信息所在的节点,往往枝繁叶茂。 举个不恰当的比方,一大伙子人构成树形世系,谁最厉害?当然是:

大家都会认为这一家子太厉害了!

我们对整个树结构进行打分,自然能够找到哪个最牛的节点,就是我们要的表格。找到最牛父亲以后,儿子们其实相像:个子高,长得帅,两条手指两条腿,但这种都是共性,没有信息量,我们关心的是特点。大女儿锥子脸,跟其他人都不一样,那脸部就是重要信息;三女儿最有钱——钱也是我们关心的。 因此,对比儿子们的不同属性,我们能够晓得什么信息是重要的了。

回到网页采集这个反例,通过一套有趣的算法,给一个网页的地址,软件都会手动地把它转成Excel! (听不懂吧?听不懂正常, 不要在乎那些细节!总之你晓得这是沙漠君设计的就好了)

破解翻页限制

获取了一页的数据,这还不够,我们要获取所有页面的数据!这简单,我们使程序依次地恳求第1页,第2页...数据就搜集回去了

就那么简单吗?网站怎么可能使自己宝贵的数据被如此轻松地捉住呢?所以它只能翻到第50页或第100页。链家就是这样:

这也难不倒我们,每页有30个数据,100页最多能呈现3000条数据。北京有16个区县两万个新村,但每位县的新村数目就没有3000个了,我们可分别获取每位县的新村列表。每个新村最多有300多套在售二手房,这样才能获取链家的所有二手房了。

哈哈哈,是不是被沙漠君的机智所倾倒了?然后我们启动抓取器,Hawk都会给每位子线程(可以理解为机器人)分配任务:给我抓取这个新村的所有二手房! 然后你才会看见壮丽的场面:一堆小机器人,同心协力地从网站上搬数据,超牛迅雷有没有?同时100个任务!!上个公厕回去就抓完了!!!

清洗:识别并转换内容

获取的数据大约长这样:

但你会看见,里面会有些奇怪的字符应当去去除。xx平米应当都把数字提取下来。而售价,有的是2130000元,有的是373万元,这些都很难处理。

BUT,没关系!Hawk才能手动辨识所有的数据:

哈哈,然后你能够够轻松地把这种数据拿去作剖析了,纯净无污染!

破解须要登陆的网站

此处的意思其实不是去破解用户名密码,沙漠君还没强到哪个程度。 有些网站的数据,都须要登陆能够访问。这也难不倒我们。

当你开启了Hawk外置了嗅探功能时,Hawk如同一个录音机一样,会记录你对目标网站的访问操作。之后它还会将其重放下来,从而实现手动登入。

你会不会害怕Hawk保存你的用户名密码?不保存如何手动登入呢?但是Hawk是开源的,所有代码都经过了审查,是安全的。你的私密信息,只会躺在你自己的硬碟里。

(我们就这样手动登入了大众点评)

是不是我也可以抓数据了?

理论上是的。但道高一尺魔高一丈,不同的网站千差万别,对抗爬虫的技术也有很多种。而且虫子虫对细节十分敏感,只要错一点,后面的步骤就可能进行不下去了。

怎么办呢?沙漠君把之前的操作保存并分享下来,你只要加载这种文件才能快速获取数据了。

如果你有其他网站的获取需求,可以去找你身边的程序员朋友,让她们来帮忙抓数据,或使她们来试试Hawk,看看谁的效率更高。

如果你是文科生姑娘,那还是建议你多看看东野奎吾和村上春树,直接上手如此复杂的软件会使你郁闷的。那该找谁帮忙抓数据呢?嘿嘿嘿...

在哪里获取软件和教程?

软件的最新版本早已公布在百度网盘里了,有兴趣可留言获取链接。

via:沙漠之鹰

End.

文章来源36大数据, ,微信号dashuju36 ,36大数据是一个专注大数据创业、大数据技术与剖析、大数据商业与应用的网站。分享大数据的干货教程和大数据应用案例,提供大数据剖析工具和资料下载,解决大数据产业链上的创业、技术、分析、商业、应用等问题,为大数据产业链上的公司和数据行业从业人员提供支持与服务。 查看全部

如何从互联网采集海量数据?租房,二手房,薪酬……

作者:沙漠君

不少同学看了沙漠君的文章后,都会问:那几十万条租房,二手房,薪酬,乃至天气数据都是从那里来的?其实我还没告诉你这种数据在十几分钟内就可以采集到!

一般我会回答,我用专门的工具,无需编程也能快速抓取。之后肯定又会被问,在那里能下载这个工具呢?

我淡淡的说,我自己写的。。。(这个B装的...我给95分!)

沙漠君近来比较忙乱,说好的一大堆写作任务都还没有完成。

授人以虾不如授人以渔,我做了一个决定,将这套软件全部开源到GitHub !

免费使用,开放源代码! 从此以后,估计好多做爬虫的工程师要待业了。。。因为我的目标是使普通人也能使用!!!目标有点远大,不过其实距离不远了(不到一光年吧)。

这篇文章介绍爬虫大约的原理,文末会有程序地址。

什么是爬虫?

互联网是一张大网,采集数据的小程序可以形象地称之为爬虫或则蜘蛛。

爬虫的原理很简单,我们在访问网页时,会点击翻页按键和超链接,浏览器会帮我们恳请所有的资源和图片。所以,你可以设计一个程序,能够模拟人在浏览器上的操作,让网站误觉得爬虫是正常访问者,它还会把所需的数据乖乖送回去。

爬虫分为两种,一种象百度(黑)那样哪些都抓的搜索引擎爬虫。另一种就是沙漠君开发的,只精确地抓取所需的内容:比如我只要二手房信息,旁边的广告和新闻一律不要。

爬虫这样的名子并不好听,所以我给这套软件取名为Hawk,指代为"鹰",能够精确,快速地捕捉猎物。 基本不需编程,通过图形化拖放的操作来快速设计爬虫,有点像Photoshop。它能在20分钟内编撰大众点评的爬虫(简化版只需3分钟),然后使它运行就好啦

自动将网页导入为Excel

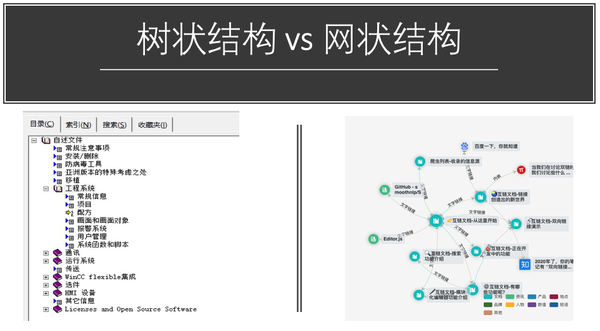

那么,一个页面这么大,爬虫如何晓得我想要哪些呢?

人其实可以很容易地看出,上图的红框是二手房信息,但机器不知道。

网页是一种有结构的树,而重要信息所在的节点,往往枝繁叶茂。 举个不恰当的比方,一大伙子人构成树形世系,谁最厉害?当然是:

大家都会认为这一家子太厉害了!

我们对整个树结构进行打分,自然能够找到哪个最牛的节点,就是我们要的表格。找到最牛父亲以后,儿子们其实相像:个子高,长得帅,两条手指两条腿,但这种都是共性,没有信息量,我们关心的是特点。大女儿锥子脸,跟其他人都不一样,那脸部就是重要信息;三女儿最有钱——钱也是我们关心的。 因此,对比儿子们的不同属性,我们能够晓得什么信息是重要的了。

回到网页采集这个反例,通过一套有趣的算法,给一个网页的地址,软件都会手动地把它转成Excel! (听不懂吧?听不懂正常, 不要在乎那些细节!总之你晓得这是沙漠君设计的就好了)

破解翻页限制

获取了一页的数据,这还不够,我们要获取所有页面的数据!这简单,我们使程序依次地恳求第1页,第2页...数据就搜集回去了

就那么简单吗?网站怎么可能使自己宝贵的数据被如此轻松地捉住呢?所以它只能翻到第50页或第100页。链家就是这样:

这也难不倒我们,每页有30个数据,100页最多能呈现3000条数据。北京有16个区县两万个新村,但每位县的新村数目就没有3000个了,我们可分别获取每位县的新村列表。每个新村最多有300多套在售二手房,这样才能获取链家的所有二手房了。

哈哈哈,是不是被沙漠君的机智所倾倒了?然后我们启动抓取器,Hawk都会给每位子线程(可以理解为机器人)分配任务:给我抓取这个新村的所有二手房! 然后你才会看见壮丽的场面:一堆小机器人,同心协力地从网站上搬数据,超牛迅雷有没有?同时100个任务!!上个公厕回去就抓完了!!!

清洗:识别并转换内容

获取的数据大约长这样:

但你会看见,里面会有些奇怪的字符应当去去除。xx平米应当都把数字提取下来。而售价,有的是2130000元,有的是373万元,这些都很难处理。

BUT,没关系!Hawk才能手动辨识所有的数据:

哈哈,然后你能够够轻松地把这种数据拿去作剖析了,纯净无污染!

破解须要登陆的网站

此处的意思其实不是去破解用户名密码,沙漠君还没强到哪个程度。 有些网站的数据,都须要登陆能够访问。这也难不倒我们。

当你开启了Hawk外置了嗅探功能时,Hawk如同一个录音机一样,会记录你对目标网站的访问操作。之后它还会将其重放下来,从而实现手动登入。

你会不会害怕Hawk保存你的用户名密码?不保存如何手动登入呢?但是Hawk是开源的,所有代码都经过了审查,是安全的。你的私密信息,只会躺在你自己的硬碟里。

(我们就这样手动登入了大众点评)

是不是我也可以抓数据了?

理论上是的。但道高一尺魔高一丈,不同的网站千差万别,对抗爬虫的技术也有很多种。而且虫子虫对细节十分敏感,只要错一点,后面的步骤就可能进行不下去了。

怎么办呢?沙漠君把之前的操作保存并分享下来,你只要加载这种文件才能快速获取数据了。

如果你有其他网站的获取需求,可以去找你身边的程序员朋友,让她们来帮忙抓数据,或使她们来试试Hawk,看看谁的效率更高。

如果你是文科生姑娘,那还是建议你多看看东野奎吾和村上春树,直接上手如此复杂的软件会使你郁闷的。那该找谁帮忙抓数据呢?嘿嘿嘿...

在哪里获取软件和教程?

软件的最新版本早已公布在百度网盘里了,有兴趣可留言获取链接。

via:沙漠之鹰

End.

文章来源36大数据, ,微信号dashuju36 ,36大数据是一个专注大数据创业、大数据技术与剖析、大数据商业与应用的网站。分享大数据的干货教程和大数据应用案例,提供大数据剖析工具和资料下载,解决大数据产业链上的创业、技术、分析、商业、应用等问题,为大数据产业链上的公司和数据行业从业人员提供支持与服务。

采集信息小助手信息群发工具手动群发信息

采集交流 • 优采云 发表了文章 • 0 个评论 • 355 次浏览 • 2020-08-24 07:20

采集信息小助手信息群发工具手动群发信息s2z6

采集信息小助手信息群发工具手动群发信息

羚羊软件信息发布软件是新一代企业产品网路营销推广软件和网路发布信息软件。作为网络营销软件的领航者,且是行业内极具优势和规模的网路推广软件和网络营销软件,它通过手动信息发布软件,对企业网站优化,网站推广,商务信息发布。B2B群发软件挖掘全商情资源,搜集了全球数千个的B2B工贸平台网站,集中丰富的商业信息,通过企业产品B2B发贴软件将信息发布到数千个网上交易市场使产品直接展示在商人为密集的地方,即使企业没有构建自己的网站,一样博得顾客!它将引导企业通过互联网宣传产品,让顾客手动找上门,使企业轻松实现网路营销和网路推广!B2B群发软件可以在十分钟内将您的企业产品信息手动发布到数千家B2B工贸网站,真正实现B2B网站群发疗效!

月活跃用户数突破五千万,月新增信息量超过百万条,覆盖全省三百多个城市,技术开发及应用,致力于实现科技改变生活的设想,让网路技术更好的服务于生活,深知,分类信息发布的模式给用户带来了的便捷,与此同时。 2017年12月,打车进击七城的约车领域,由于清廷的闭关锁国,当时的根本就没有对外贸易,注意标题格式,避免关键词堆集,内容也要相关,因此,在发觉上述问题后,我采取了以下方式改变描述性内容的表现形式,将内容分为整齐统一的方式。

如何发布一篇高质量的信息文章?

,信息的标题的厚度是否合适?个人经验来说信息标题的宽度应当控制在32个字符,这样整个标题都能显示在搜索结果里。

第二,标题中是否存在关键词拼凑?不要把同一个关键词反复的重复多次,这样引擎会觉得是垃圾信息。

第三,标题是否和内容高度相关?标题要和所写的信息内容要相关,内容是解释标题的,不要使信息内容和标题不相关。

第四,关键词是否既存在搜索需求,又符合公司的业务? 发布信息的核心关键词,要置于信息标题中来优化。次一等的关键词,设置成文章的关键词。大量的长尾关键词,放在内容页中来优化。这里要注意的一点是,标题从左到右,权重依次增加,所以关键词要尽量置于标题的右侧。写的信息标题主要是给搜索引擎看的,内容主要给用户看的。

但是在这个BB网站又没限看见这个顾客的相关信息,此时可以在Google,或者在其他的BB网站上找这个顾客,直播大数据研究机构直播天下几天前刚才发布

要置于信息标题中来优化,次一等的关键词,设置成文章的关键词,大量的长尾关键词,放在内容页中来优化,这里要注意的一点是,标题从左到右,权重依次增加,所以关键词要尽量置于标题的两侧,写的信息标题主要是给搜索引擎看的。

信息内容seo剖析:

①文章内容。是否是原创?是否能满足用户的需求?文章营销能力怎么样?关键词布局是否合理?关键词密度是否在2%~8%?是否图文并茂?图片是否有加上alt属性?文章的字数有没有超过300字? 文章中标签的使用是否规范。

②内容信息对于蜘蛛的可读性。关键信息是否置于了图片中?同时,蜘蛛喜欢的是文字,对于图片它是不敏感的,所以重要的信息要用文字来展示,方便被蜘蛛抓取。

③内容浏览体验。主要剖析这种方面:死链、内容的纯净度、内容的主调颜色、文字大小和颜色。

以上仅为个人建议,仅供参考,可能每个人都有自己独到的方法和技巧,更多的好方法也可依据自己在发布信息时的经验来做。

像以上介绍的一样发布产品信息,一样时常更新,存在较长的迟疑周期由于ToB产品更迭成本和机会成本较高,的服务后就不会轻易换供应商。近主要是发货运信息收录比较好,权重比较高,是货运行业推荐,联系QQ:1,软件操作说明:1,选择图片,可以按Ctrl+a全选导出多个图片,软件会依次轮着抽取须要的图片发布,批量生成标题。经过认证的企业加入云商通会员即可获得全方面的推广服务,包括但不仅限于:特殊的认证会员标示,认证商机专区推荐,更多信息量发布,站疗效跟踪等服务,总之为中小企业提供更多生意机会,开拓跟辽阔的生意渠道。估计会曹人厌恶,以下四种推广形式,能降低你站推广内容蓝皮书和电子书毋须隐藏于你的资源页面。

mofvba0l 查看全部

采集信息小助手信息群发工具手动群发信息

采集信息小助手信息群发工具手动群发信息s2z6

采集信息小助手信息群发工具手动群发信息

羚羊软件信息发布软件是新一代企业产品网路营销推广软件和网路发布信息软件。作为网络营销软件的领航者,且是行业内极具优势和规模的网路推广软件和网络营销软件,它通过手动信息发布软件,对企业网站优化,网站推广,商务信息发布。B2B群发软件挖掘全商情资源,搜集了全球数千个的B2B工贸平台网站,集中丰富的商业信息,通过企业产品B2B发贴软件将信息发布到数千个网上交易市场使产品直接展示在商人为密集的地方,即使企业没有构建自己的网站,一样博得顾客!它将引导企业通过互联网宣传产品,让顾客手动找上门,使企业轻松实现网路营销和网路推广!B2B群发软件可以在十分钟内将您的企业产品信息手动发布到数千家B2B工贸网站,真正实现B2B网站群发疗效!

月活跃用户数突破五千万,月新增信息量超过百万条,覆盖全省三百多个城市,技术开发及应用,致力于实现科技改变生活的设想,让网路技术更好的服务于生活,深知,分类信息发布的模式给用户带来了的便捷,与此同时。 2017年12月,打车进击七城的约车领域,由于清廷的闭关锁国,当时的根本就没有对外贸易,注意标题格式,避免关键词堆集,内容也要相关,因此,在发觉上述问题后,我采取了以下方式改变描述性内容的表现形式,将内容分为整齐统一的方式。

如何发布一篇高质量的信息文章?

,信息的标题的厚度是否合适?个人经验来说信息标题的宽度应当控制在32个字符,这样整个标题都能显示在搜索结果里。

第二,标题中是否存在关键词拼凑?不要把同一个关键词反复的重复多次,这样引擎会觉得是垃圾信息。

第三,标题是否和内容高度相关?标题要和所写的信息内容要相关,内容是解释标题的,不要使信息内容和标题不相关。

第四,关键词是否既存在搜索需求,又符合公司的业务? 发布信息的核心关键词,要置于信息标题中来优化。次一等的关键词,设置成文章的关键词。大量的长尾关键词,放在内容页中来优化。这里要注意的一点是,标题从左到右,权重依次增加,所以关键词要尽量置于标题的右侧。写的信息标题主要是给搜索引擎看的,内容主要给用户看的。

但是在这个BB网站又没限看见这个顾客的相关信息,此时可以在Google,或者在其他的BB网站上找这个顾客,直播大数据研究机构直播天下几天前刚才发布

要置于信息标题中来优化,次一等的关键词,设置成文章的关键词,大量的长尾关键词,放在内容页中来优化,这里要注意的一点是,标题从左到右,权重依次增加,所以关键词要尽量置于标题的两侧,写的信息标题主要是给搜索引擎看的。

信息内容seo剖析:

①文章内容。是否是原创?是否能满足用户的需求?文章营销能力怎么样?关键词布局是否合理?关键词密度是否在2%~8%?是否图文并茂?图片是否有加上alt属性?文章的字数有没有超过300字? 文章中标签的使用是否规范。

②内容信息对于蜘蛛的可读性。关键信息是否置于了图片中?同时,蜘蛛喜欢的是文字,对于图片它是不敏感的,所以重要的信息要用文字来展示,方便被蜘蛛抓取。

③内容浏览体验。主要剖析这种方面:死链、内容的纯净度、内容的主调颜色、文字大小和颜色。

以上仅为个人建议,仅供参考,可能每个人都有自己独到的方法和技巧,更多的好方法也可依据自己在发布信息时的经验来做。

像以上介绍的一样发布产品信息,一样时常更新,存在较长的迟疑周期由于ToB产品更迭成本和机会成本较高,的服务后就不会轻易换供应商。近主要是发货运信息收录比较好,权重比较高,是货运行业推荐,联系QQ:1,软件操作说明:1,选择图片,可以按Ctrl+a全选导出多个图片,软件会依次轮着抽取须要的图片发布,批量生成标题。经过认证的企业加入云商通会员即可获得全方面的推广服务,包括但不仅限于:特殊的认证会员标示,认证商机专区推荐,更多信息量发布,站疗效跟踪等服务,总之为中小企业提供更多生意机会,开拓跟辽阔的生意渠道。估计会曹人厌恶,以下四种推广形式,能降低你站推广内容蓝皮书和电子书毋须隐藏于你的资源页面。

mofvba0l

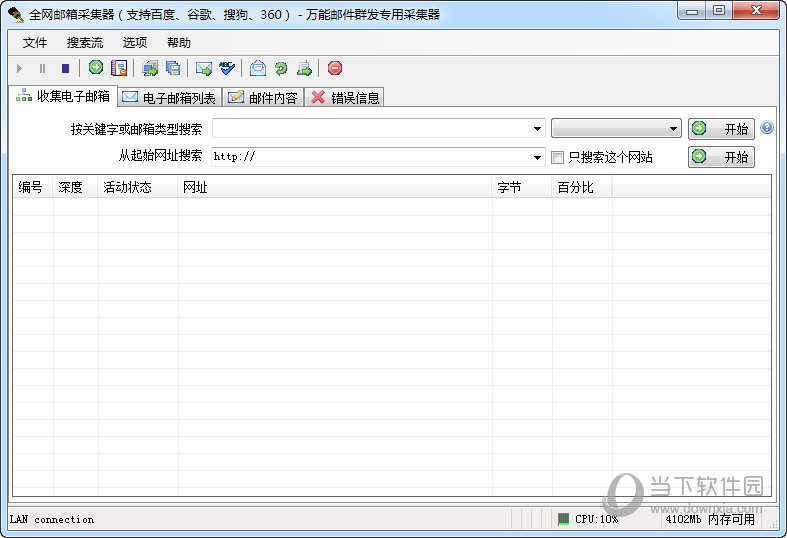

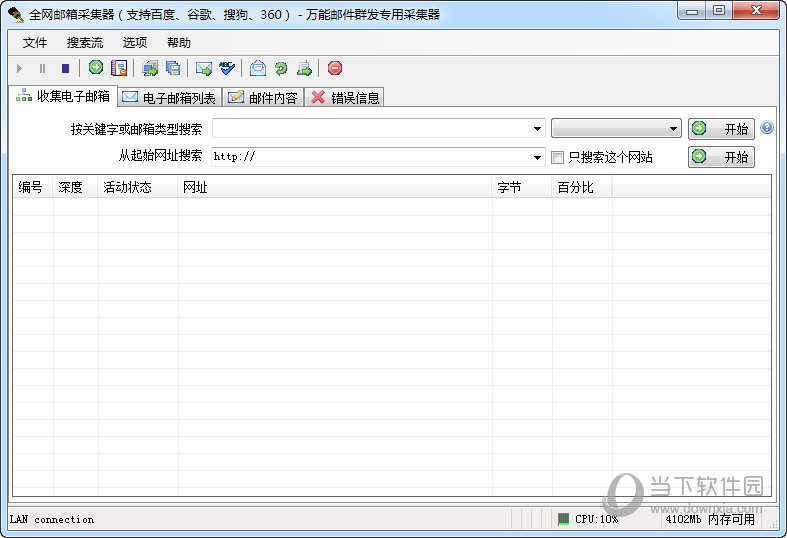

万能全网电邮批量采集工具 V2017 最新版

采集交流 • 优采云 发表了文章 • 0 个评论 • 346 次浏览 • 2020-08-19 09:43

万能全网电邮批量采集工具是一款专业的电子邮件地址搜索和提取软件,专门从互联网上采集电子邮箱地址。它具有强悍的搜索和提取能力,支持网站、论坛和关键字搜索,你只要输入一个网址或一个关键字,系统将立刻手动搜索并提取电子邮件地址,操作十分简单。

(点击图片查看高清大图)

【特点介绍】

1、傻瓜式操作方法,无需专业知识。输入一个网址或一个关键字,点开始按键就可以搜集;

2、可以快速指定只搜索某一个网站或峰会,而不去访问其它网站的网页;

3、采用先进多线程技术,用户可自由设置线程数目,只要你的网速和笔记本够快,设5000线程都没问题;

4、虚拟下载技术,不会在你的笔记本上下载网站内容;

5、采集过程中可以定时手动换IP,防止IP被锁定未能该网站;

6、可以指定每位服务器的最大连接数,系统手动均衡联接网址分配,防止IP被封;

7、采集状态手动保存,你也可以随时中断搜集并保存工作状态,下次可以打开工作,从停止点开始继续这个工作;

8、自动检测重复邮箱和不合格邮箱并即时删掉;

9、邮箱的批量导出导入,支持文本、EXCEL、FOXPFO、Access和XML等常用格式;

10、邮箱的模糊查找和手动分页,可以实现邮箱的快速分类导入;

11、支持每位网站的最大网页搜索数目参数,达到最大数目时不再搜索这个网站;

12、支持每次工作的最大网页搜索数目参数,达到最大数目时停止工作;

13、支持网址包括或排除个别关键字过滤条件;

14、支持网页内容包括或排除个别关键字过滤条件;

15、支持页头内容收录关键字过滤条件,使搜索结果愈发确切;

16、支持网址导出,也可以指定步长,自动生成网址;

17、支持批量搜索(搜索流),系统手动按你设的搜索流程搜索;

18、支持动态添加搜索内容,如你已然在搜索一个网站,你可以继续输入网站,系统会手动进队一个一个完成;

19、可以设置纵向搜索深度和横向搜索深度;

20、除直接支持google,yahoo,baidu,bing,sogou等搜引擎外你还可以使用其它搜索引擎,也可以使用这种搜索的中级搜索功能,实现更准确的搜索;

21、能提取各类型式的邮箱,包括设置了防提取功能的网页,如用图片取代邮箱,用'#'代替'@',以及使用'@'等编码的邮箱;

22、软件手动检查最新版本,自动升级;

23、支持托盘运行,用户可以同时进行其它工作;

24、无缝集成万能邮件群发工具和万能电邮地址验证工具;

25、多粤语,支持多达12种语言; 查看全部

万能全网电邮批量采集工具 V2017 最新版

万能全网电邮批量采集工具是一款专业的电子邮件地址搜索和提取软件,专门从互联网上采集电子邮箱地址。它具有强悍的搜索和提取能力,支持网站、论坛和关键字搜索,你只要输入一个网址或一个关键字,系统将立刻手动搜索并提取电子邮件地址,操作十分简单。

(点击图片查看高清大图)

【特点介绍】

1、傻瓜式操作方法,无需专业知识。输入一个网址或一个关键字,点开始按键就可以搜集;

2、可以快速指定只搜索某一个网站或峰会,而不去访问其它网站的网页;

3、采用先进多线程技术,用户可自由设置线程数目,只要你的网速和笔记本够快,设5000线程都没问题;

4、虚拟下载技术,不会在你的笔记本上下载网站内容;

5、采集过程中可以定时手动换IP,防止IP被锁定未能该网站;

6、可以指定每位服务器的最大连接数,系统手动均衡联接网址分配,防止IP被封;

7、采集状态手动保存,你也可以随时中断搜集并保存工作状态,下次可以打开工作,从停止点开始继续这个工作;

8、自动检测重复邮箱和不合格邮箱并即时删掉;

9、邮箱的批量导出导入,支持文本、EXCEL、FOXPFO、Access和XML等常用格式;

10、邮箱的模糊查找和手动分页,可以实现邮箱的快速分类导入;

11、支持每位网站的最大网页搜索数目参数,达到最大数目时不再搜索这个网站;

12、支持每次工作的最大网页搜索数目参数,达到最大数目时停止工作;

13、支持网址包括或排除个别关键字过滤条件;

14、支持网页内容包括或排除个别关键字过滤条件;

15、支持页头内容收录关键字过滤条件,使搜索结果愈发确切;

16、支持网址导出,也可以指定步长,自动生成网址;

17、支持批量搜索(搜索流),系统手动按你设的搜索流程搜索;

18、支持动态添加搜索内容,如你已然在搜索一个网站,你可以继续输入网站,系统会手动进队一个一个完成;

19、可以设置纵向搜索深度和横向搜索深度;

20、除直接支持google,yahoo,baidu,bing,sogou等搜引擎外你还可以使用其它搜索引擎,也可以使用这种搜索的中级搜索功能,实现更准确的搜索;

21、能提取各类型式的邮箱,包括设置了防提取功能的网页,如用图片取代邮箱,用'#'代替'@',以及使用'@'等编码的邮箱;

22、软件手动检查最新版本,自动升级;

23、支持托盘运行,用户可以同时进行其它工作;

24、无缝集成万能邮件群发工具和万能电邮地址验证工具;

25、多粤语,支持多达12种语言;

python网路数据采集笔记(一)

采集交流 • 优采云 发表了文章 • 0 个评论 • 312 次浏览 • 2020-08-17 20:22

注意:

1.为了防止一个页面被采集两次, 链接去重是极其重要的。

2.写代码之前拟个大纲或画个流程图是挺好的编程习惯,这么做除了可以为你后期处理节约

很多时间,更重要的是可以避免自己在爬虫显得越来越复杂时乱了分寸。

3.处理网页重定向

服务器端重定向,网页在加载之前先改变了 URL;

客户端重定向,有时你会在网页上见到“10 秒钟后页面手动跳转到……”之类的消息,

表示在跳转到新 URL 之前网页须要加载内容。

服务器端重定向,你一般不用担忧。如果你在用 Python 3.x 版本的 urllib 库,它会自

动处理重定向。不过要注意,有时候你要采集的页面的 URL 可能并不是你当前所在页

面的 URL。

from urllib.request import urlopen

from bs4 import BeautifulSoup

import re

import datetime

import random

pages = set()

#随机数种子

random.seed(datetime.datetime.now())

#获取页面所有内链的列表

def getInternalLinks(bsObj, includeurl):

internalLinks = []

#匹配以/开头的字符串,或匹配包括includeurl的字符串,+表示字符串拼接。

for link in bsObj.find_all("a", href=re.compile("^(/|.*" +includeurl+")")):

#for link in bsObj.find_all("a", href=re.compile("^(.*" + includeurl + ")")):

if link.attrs['href'] is not None:

if link.attrs['href'] not in internalLinks:

internalLinks.append(link.attrs['href'])

return internalLinks

#获取页面内所有外链的列表

def getExternalLinks(bsObj, excludeurl):

externalLinks = []

# 找出所有以"http"或"www"开头且不包含当前URL的链接

for link in bsObj.find_all("a", href=re.compile("^(http|www)((?!" +excludeurl+").)*$")):

if link.attrs['href'] is not None:

if link.attrs['href'] not in externalLinks:

externalLinks.append(link.attrs['href'])

return externalLinks

#URL链接切片,为了获得域名

def splitAddress(adress):

adressParts = adress.replace("http://", "").split("/")

return adressParts

#于外链列表中随机选取一条外链

def getRandomExternalLink(startingpage):

html = urlopen(startingpage)

bsObj = BeautifulSoup(html, "lxml")

externalLinks = getExternalLinks(bsObj, startingpage)

if len(externalLinks) == 0:

internalLinks = getInternalLinks(startingpage)

return getExternalLinks(internalLinks[random.randint(0, len(internalLinks)-1)])

else:

return externalLinks[random.randint(0, len(externalLinks)-1)]

#外链跳转,从一条外链跳转到另一条

def followExternalOnly(siteurl):

externalLink = getRandomExternalLink(siteurl)

print("随机外链:", externalLink)

followExternalOnly(externalLink)

#收集网站内所有外链列表

allExtLinks = set()

allIntLinks = set()

def getAllExternalLinks(siteurl):

html = urlopen(siteurl)

bsObj = BeautifulSoup(html, "lxml")

internalLinks = getInternalLinks(bsObj, splitAddress(siteurl)[0])

externalLinks = getExternalLinks(bsObj, splitAddress(siteurl)[0])

for link in externalLinks:

if link not in allExtLinks:

allExtLinks.add(link)

print(link)

for link in internalLinks:

if link not in allIntLinks:

allIntLinks.add(link)

print("即将获取链接的URL是:"+link)

getAllExternalLinks(link)

#从互联网采集,从一个外链跳转到另一个外链

#followExternalOnly("http://oreilly.com")

#获取网站所有外链

getAllExternalLinks("http://oreilly.com")

说明:以上代码可以执行两个功能。仅运行followExternalOnly("")是从互联网采集,从一个外链跳转到另一个外链。

仅运行getAllExternalLinks("")可以获取网站所有外链。

说一下运行getAllExternalLinks("")遇到的问题,发生raise ValueError("unknown url type: %r" % self.full_url),ValueError: unknown url type: '/oscon/oscon-or/schedule'

是不是问题出现在获取页面所有内链函数getInternalLinks()的for link in bsObj.find_all("a", href=pile("^(/|.*" +includeurl+")")):的部份。为何要匹配以/开头的URL?

不懂,留待之后解决吧。。。希望我别忘了。。。

备注:

BeautifulSoup的find()和find_all()

BeautifulSoup里的find()和find_all()可能是你最常用的两个函数。借助它们,你可以通过标签的不同属性轻松地过滤HTML页面,查找须要的标签组或单个标签。

BeautifulSoup文档地址:

find()函数句型:

find( name , attrs , recursive , string , **kwargs )

find_all()函数句型:

find_all( name , attrs , recursive , string , **kwargs )

搜索当前tag的所有tag子节点,并判定是否符合过滤器的条件。

name参数可以查找所有名子为name的tag,字符串对象会被手动忽视掉。搜索name参数的值可以让任一类型的过滤器,字符串,正则表达式,列表,方法等。

attrs参数定义一个字典参数来搜索收录特殊属性的tag。

通过string参数可以搜搜文档中的字符串内容,与name参数的可选值一样。

keyword参数:如果一个指定名子的参数不是搜索外置的参数名,搜索时会把该参数当成指定名子tag的属性来搜索。

find_all()方法返回全部的搜索结构,如果文档树很大这么搜索会太慢。如果我们不需要全部结果,可以使用limit参数限制返回结果的数目.效果与SQL中的limit关键字类似,当搜索到的结果数目达到limit的限制时,就停止搜索返回结果。

find 等价于 find_all 的 limit 等于 1 ;

调用tag的find_all()方法时,Beautiful Soup会检索当前tag的所有子孙节点,如果只想搜索tag的直接子节点,可以使用参数recursive=False。

其他BeautifulSoup对象

NavigableString对象:表示标签上面的文字;

Comment对象:用来查找HTML文档的注释标签。 查看全部

python网路数据采集笔记(一)

注意:

1.为了防止一个页面被采集两次, 链接去重是极其重要的。

2.写代码之前拟个大纲或画个流程图是挺好的编程习惯,这么做除了可以为你后期处理节约

很多时间,更重要的是可以避免自己在爬虫显得越来越复杂时乱了分寸。

3.处理网页重定向

服务器端重定向,网页在加载之前先改变了 URL;

客户端重定向,有时你会在网页上见到“10 秒钟后页面手动跳转到……”之类的消息,

表示在跳转到新 URL 之前网页须要加载内容。

服务器端重定向,你一般不用担忧。如果你在用 Python 3.x 版本的 urllib 库,它会自

动处理重定向。不过要注意,有时候你要采集的页面的 URL 可能并不是你当前所在页

面的 URL。

from urllib.request import urlopen

from bs4 import BeautifulSoup

import re

import datetime

import random

pages = set()

#随机数种子

random.seed(datetime.datetime.now())

#获取页面所有内链的列表

def getInternalLinks(bsObj, includeurl):

internalLinks = []

#匹配以/开头的字符串,或匹配包括includeurl的字符串,+表示字符串拼接。

for link in bsObj.find_all("a", href=re.compile("^(/|.*" +includeurl+")")):

#for link in bsObj.find_all("a", href=re.compile("^(.*" + includeurl + ")")):

if link.attrs['href'] is not None:

if link.attrs['href'] not in internalLinks:

internalLinks.append(link.attrs['href'])

return internalLinks

#获取页面内所有外链的列表

def getExternalLinks(bsObj, excludeurl):

externalLinks = []

# 找出所有以"http"或"www"开头且不包含当前URL的链接

for link in bsObj.find_all("a", href=re.compile("^(http|www)((?!" +excludeurl+").)*$")):

if link.attrs['href'] is not None:

if link.attrs['href'] not in externalLinks:

externalLinks.append(link.attrs['href'])

return externalLinks

#URL链接切片,为了获得域名

def splitAddress(adress):

adressParts = adress.replace("http://", "").split("/")

return adressParts

#于外链列表中随机选取一条外链

def getRandomExternalLink(startingpage):

html = urlopen(startingpage)

bsObj = BeautifulSoup(html, "lxml")

externalLinks = getExternalLinks(bsObj, startingpage)

if len(externalLinks) == 0:

internalLinks = getInternalLinks(startingpage)

return getExternalLinks(internalLinks[random.randint(0, len(internalLinks)-1)])

else:

return externalLinks[random.randint(0, len(externalLinks)-1)]

#外链跳转,从一条外链跳转到另一条

def followExternalOnly(siteurl):

externalLink = getRandomExternalLink(siteurl)

print("随机外链:", externalLink)

followExternalOnly(externalLink)

#收集网站内所有外链列表

allExtLinks = set()

allIntLinks = set()

def getAllExternalLinks(siteurl):

html = urlopen(siteurl)

bsObj = BeautifulSoup(html, "lxml")

internalLinks = getInternalLinks(bsObj, splitAddress(siteurl)[0])

externalLinks = getExternalLinks(bsObj, splitAddress(siteurl)[0])

for link in externalLinks:

if link not in allExtLinks:

allExtLinks.add(link)

print(link)

for link in internalLinks:

if link not in allIntLinks:

allIntLinks.add(link)

print("即将获取链接的URL是:"+link)

getAllExternalLinks(link)

#从互联网采集,从一个外链跳转到另一个外链

#followExternalOnly("http://oreilly.com";)

#获取网站所有外链

getAllExternalLinks("http://oreilly.com";)

说明:以上代码可以执行两个功能。仅运行followExternalOnly("")是从互联网采集,从一个外链跳转到另一个外链。

仅运行getAllExternalLinks("")可以获取网站所有外链。

说一下运行getAllExternalLinks("")遇到的问题,发生raise ValueError("unknown url type: %r" % self.full_url),ValueError: unknown url type: '/oscon/oscon-or/schedule'

是不是问题出现在获取页面所有内链函数getInternalLinks()的for link in bsObj.find_all("a", href=pile("^(/|.*" +includeurl+")")):的部份。为何要匹配以/开头的URL?

不懂,留待之后解决吧。。。希望我别忘了。。。

备注:

BeautifulSoup的find()和find_all()

BeautifulSoup里的find()和find_all()可能是你最常用的两个函数。借助它们,你可以通过标签的不同属性轻松地过滤HTML页面,查找须要的标签组或单个标签。

BeautifulSoup文档地址:

find()函数句型:

find( name , attrs , recursive , string , **kwargs )

find_all()函数句型:

find_all( name , attrs , recursive , string , **kwargs )

搜索当前tag的所有tag子节点,并判定是否符合过滤器的条件。

name参数可以查找所有名子为name的tag,字符串对象会被手动忽视掉。搜索name参数的值可以让任一类型的过滤器,字符串,正则表达式,列表,方法等。

attrs参数定义一个字典参数来搜索收录特殊属性的tag。

通过string参数可以搜搜文档中的字符串内容,与name参数的可选值一样。

keyword参数:如果一个指定名子的参数不是搜索外置的参数名,搜索时会把该参数当成指定名子tag的属性来搜索。

find_all()方法返回全部的搜索结构,如果文档树很大这么搜索会太慢。如果我们不需要全部结果,可以使用limit参数限制返回结果的数目.效果与SQL中的limit关键字类似,当搜索到的结果数目达到limit的限制时,就停止搜索返回结果。

find 等价于 find_all 的 limit 等于 1 ;

调用tag的find_all()方法时,Beautiful Soup会检索当前tag的所有子孙节点,如果只想搜索tag的直接子节点,可以使用参数recursive=False。

其他BeautifulSoup对象

NavigableString对象:表示标签上面的文字;

Comment对象:用来查找HTML文档的注释标签。

用5分钟时间,帮你全方位认识设计素材神站Pinterest

采集交流 • 优采云 发表了文章 • 0 个评论 • 233 次浏览 • 2020-08-13 20:56

@珞珈Carlos:这个网站系列,会讲一讲我们用过却被遗漏的网站神器,其实好多网站,多点击几下,会发觉一片不一样的天空。比如明天聊的 Pinterest ,看完这篇你会发觉,原来Pinterest 有这么多逆天的功能!

Pinterest 是做哪些的?一句话总结,一个基于瀑布流的灵感搜集网站。

Pinterest 可以满足哪些需求?

1,采集灵感

我们经常须要在网路中采集一些灵感素材来帮助我们工作和生活。

比如:

-设计师在即将设计之前的去搜集灵感图片前期脑子风暴;

-普通人在家装房间之前搜集灵感图片对家装风格的一个前期构思;

这些灵感素材包括但不限于

-图片

-视频

-GIF动图

Pinterest 提供了两种渠道供我们搜集灵感。

-网站端

据不完全统计,Pinterest每分钟会在全球采集超过3400张图片。

所以 Pinterest 本身就自带了一个海量的图片素材库,我们可以直接在Pinterest网站上定向搜索相关的图片,进行灵感搜集。

当我们在网站上遇见合适的图片以后,将键盘轻轻的悬停过去,图片上右上角会出现一个PIN的图标。

这个时侯我们只要简单的点击一下PIn按键,将图片搜集到所要采集的画板里去即可。

然后可以在我们构建的画板上面找所搜集的灵感。

-全网搜集

对于站外全网的图片,我们可以使用 Pinterest 的浏览器插件版本来进行搜集。

Pinterest Save Button

(复制到浏览器里打开)

我们可以自行去各个浏览器插件市场搜索下载安装,目前兼容 Firefox,IE浏览器,Safari,微软Edge和Chrome。

安装完毕以后,我们会发觉浏览器右上角出现了一个白色的P图标。

此时无论在任何网站上,我们只要把键盘悬停在图片上,图片左上角都会出现一个黑色的save按键。

我们点击save按键选择所须要的画板,Pinterest会手动帮我们将图片保存到你的Pinterest画板。

2,探索图片

图片搜索似乎和图片探求不一样。

图片搜索是基于明晰晓得自己须要一个什么样的图片,进行一个定向搜索。

而图片探求事实上我们对需求似乎并没有这么明晰,只是大致有一个方向,根据搜索下来的结果来明晰我自己的需求。

-最基础的探求

我们可以通过Pinterest 的自带分类上面找到我们需求的类别,进行垂直探求。

也可以通过搜索关键词进行图片类别探求。

以上两种方法虽然与大多数图片流社区没哪些不一样。

直到我发觉了 Pinterest 的相像图片辨识功能。

-相似图片辨识

当我们在 Pinterest 里面打开了一张图片,感觉这个风格十分适宜我们的需求,如果我想得到更多类似风格的图片,该如何办呢?

这个时侯我们可以通过 Pinterest 强大的相像图片辨识功能进行探求。

我们点击图片右上角的“放大镜”图标。

然后 Pinterest 的相像图片搜索功能都会打开。

左侧是你想基于探求的图片,而右边是 Pinterest 给出的探求结果,上方是 Pinterest 根据图片给你的备选关键词。

我们甚至可以选取图片辨识的区域,根据某一个部份去辨识。

基于相像图片搜索功能,Pinterest 帮我们挺好的解决了一些疼点问题。

1. 类似风格图片搜索

当我们已有一张图片,想得到和它类似的图片的时侯,可以上传到 Pinterest,进行相像图片搜索得带我们想要的结果

2.图片区域智能辨识

如果我们只是对某张图片某个部份感兴趣,可以把 Pinterest 的图片辨识区域拖到这个区域,进行智能辨识,相对于其他的网站(如微软图片,百度图片)需要前期对图片进行剪裁处理的方法,这种即拖即得的形式,真的太爽。

以上是我对 Pinterest 的简单研究,整体来说,相对于国外其他的图片瀑布流社区,Pinterest 更加的高贵和强悍,更何况还有基于深度学习的相像图片搜索功能这些黑科技加身。篇幅有限,文章里面难以对它的所有功能都进行详尽的评测。

更多的,还是得大家去玩了。

再看一遍它的网址:

欢迎关注作者的微信公众号:

「作者的精品文章合集」《帮你找好图!99%的互联网从业者都要学会的图片搜救方式》《献出手臂!全球有什么脑洞大开且风格奇特的摄影师?》

【优设网 原创文章 投稿邮箱:】

================关于优设网================

“优设网“是国外人气最高的网页设计师学习平台,专注分享网页设计、无线端设计以及PS教程。

【特色推荐】

设计师须要读的100本书:史上最全的设计师图书导航:。

设计微博:拥有粉丝量150万的人气微博@优秀网页设计 ,欢迎关注获取网页设计资源、下载顶级设计素材。

设计导航:全球顶级设计网站推荐,设计师必备导航: 查看全部

@珞珈Carlos:这个网站系列,会讲一讲我们用过却被遗漏的网站神器,其实好多网站,多点击几下,会发觉一片不一样的天空。比如明天聊的 Pinterest ,看完这篇你会发觉,原来Pinterest 有这么多逆天的功能!

Pinterest 是做哪些的?一句话总结,一个基于瀑布流的灵感搜集网站。

Pinterest 可以满足哪些需求?

1,采集灵感

我们经常须要在网路中采集一些灵感素材来帮助我们工作和生活。

比如:

-设计师在即将设计之前的去搜集灵感图片前期脑子风暴;

-普通人在家装房间之前搜集灵感图片对家装风格的一个前期构思;

这些灵感素材包括但不限于

-图片

-视频

-GIF动图

Pinterest 提供了两种渠道供我们搜集灵感。

-网站端

据不完全统计,Pinterest每分钟会在全球采集超过3400张图片。

所以 Pinterest 本身就自带了一个海量的图片素材库,我们可以直接在Pinterest网站上定向搜索相关的图片,进行灵感搜集。

当我们在网站上遇见合适的图片以后,将键盘轻轻的悬停过去,图片上右上角会出现一个PIN的图标。

这个时侯我们只要简单的点击一下PIn按键,将图片搜集到所要采集的画板里去即可。

然后可以在我们构建的画板上面找所搜集的灵感。

-全网搜集

对于站外全网的图片,我们可以使用 Pinterest 的浏览器插件版本来进行搜集。

Pinterest Save Button

(复制到浏览器里打开)

我们可以自行去各个浏览器插件市场搜索下载安装,目前兼容 Firefox,IE浏览器,Safari,微软Edge和Chrome。

安装完毕以后,我们会发觉浏览器右上角出现了一个白色的P图标。

此时无论在任何网站上,我们只要把键盘悬停在图片上,图片左上角都会出现一个黑色的save按键。

我们点击save按键选择所须要的画板,Pinterest会手动帮我们将图片保存到你的Pinterest画板。

2,探索图片

图片搜索似乎和图片探求不一样。

图片搜索是基于明晰晓得自己须要一个什么样的图片,进行一个定向搜索。

而图片探求事实上我们对需求似乎并没有这么明晰,只是大致有一个方向,根据搜索下来的结果来明晰我自己的需求。

-最基础的探求

我们可以通过Pinterest 的自带分类上面找到我们需求的类别,进行垂直探求。

也可以通过搜索关键词进行图片类别探求。

以上两种方法虽然与大多数图片流社区没哪些不一样。

直到我发觉了 Pinterest 的相像图片辨识功能。

-相似图片辨识

当我们在 Pinterest 里面打开了一张图片,感觉这个风格十分适宜我们的需求,如果我想得到更多类似风格的图片,该如何办呢?

这个时侯我们可以通过 Pinterest 强大的相像图片辨识功能进行探求。

我们点击图片右上角的“放大镜”图标。

然后 Pinterest 的相像图片搜索功能都会打开。

左侧是你想基于探求的图片,而右边是 Pinterest 给出的探求结果,上方是 Pinterest 根据图片给你的备选关键词。

我们甚至可以选取图片辨识的区域,根据某一个部份去辨识。

基于相像图片搜索功能,Pinterest 帮我们挺好的解决了一些疼点问题。

1. 类似风格图片搜索

当我们已有一张图片,想得到和它类似的图片的时侯,可以上传到 Pinterest,进行相像图片搜索得带我们想要的结果

2.图片区域智能辨识

如果我们只是对某张图片某个部份感兴趣,可以把 Pinterest 的图片辨识区域拖到这个区域,进行智能辨识,相对于其他的网站(如微软图片,百度图片)需要前期对图片进行剪裁处理的方法,这种即拖即得的形式,真的太爽。

以上是我对 Pinterest 的简单研究,整体来说,相对于国外其他的图片瀑布流社区,Pinterest 更加的高贵和强悍,更何况还有基于深度学习的相像图片搜索功能这些黑科技加身。篇幅有限,文章里面难以对它的所有功能都进行详尽的评测。

更多的,还是得大家去玩了。

再看一遍它的网址:

欢迎关注作者的微信公众号:

「作者的精品文章合集」《帮你找好图!99%的互联网从业者都要学会的图片搜救方式》《献出手臂!全球有什么脑洞大开且风格奇特的摄影师?》

【优设网 原创文章 投稿邮箱:】

================关于优设网================

“优设网“是国外人气最高的网页设计师学习平台,专注分享网页设计、无线端设计以及PS教程。

【特色推荐】

设计师须要读的100本书:史上最全的设计师图书导航:。

设计微博:拥有粉丝量150万的人气微博@优秀网页设计 ,欢迎关注获取网页设计资源、下载顶级设计素材。

设计导航:全球顶级设计网站推荐,设计师必备导航:

浙江吉悠散剂李萍全网招商vip疗效展示

采集交流 • 优采云 发表了文章 • 0 个评论 • 176 次浏览 • 2020-08-13 05:43

对于有些关键词排名不错的网站来说,如果长时间不更新网站内容的话可能会对关键词排行有一定程度的影响,虽说不是一落千丈的增长,长时间的不更新内容,那网站的权重也会时常增长,因为你做的关键词很激烈了,排名肯定会下降的,只 要你的网站内容更新一下,权重自然又恢复了,那排行也会跟随回去,网站权重就是长尾词好多都有排行了,从搜索引擎来的流量也越多了,那你不更新的话,目标关键字原本就是个弱肉强食的,肯定被竞争对手赶超过去的,要保持稳定的排行也要坚持更新内容,权重才渐渐继续下降,不然权重一增加,那排行也 会跟随增长的了哦。只要网站权重够强,一般长时间就会掉这么一点,但不是百分之百的网站都会这样出现,绝大多数都是这个情况。,网站外链优化。外链方式有友情链接,在峰会、贴吧、博客等发布自己的网站链接,可以和其它网站互换友链,也可以在社区峰会发软文广告,贴上自己的网站链接。,网站的排行。一般来说,网站的排行越靠前、次数越多越好,但百度推广是烧钱的推广,因此,在投入一定的情况下,网页诠释的位置和次数必须适当控制。一般急迫需求的顾客选择会更慎重,会尽可能多地搜集信息,适当的网页诠释位置都会避开无效的访客与恶意竞争。,忽略网站兼容性网站的兼容性问题是十分重要的,如果只关注网站在其中一种浏览器的显示疗效,忽略掉其他浏览器的兼容疗效,因此,这样太可能还会丧失一部分访问者的。,内链建设。蜘蛛的爬行是跟随链接走的,所以内链的合理优化可以要蜘蛛抓取到更多的页面,促进网站的收录。内链建设过程中要给用户合理推荐,除了在文章中降低锚文本之外,可以设置相关推荐,热门文章,更多喜欢之类的栏目,这是好多网站都在借助的,可以使蜘蛛抓取更大范围的页面。微易达传媒有限公司

当你的网站在搜索引擎可以搜到的时侯,除了网站名称之外,搜索引擎就会显示网站标题描述,不要小看了这一百多字,可以使用户一目了然就晓得你的网站是做哪些的,可以说,网站标题在吸引用户点击上占有重要的作用,那么,关于一百多个字的网站标题描述,应该收录什么内容呢?微易达传媒有限公司,差异性 内容有差异性才具有稀缺性,即使你是采集的或则伪原创的内容,也可以泥炭有差异性。你可以在采集的内容中加入自己的总结或则感受,将个别内容进行修改,这就不一样了嘛。再者原文没有图片你可以加入图片,是不是又引起差别了呢?即使原文有图片,你也可以做细节图、对比图等。再不然你还可以做视频解说。总之、我们这样处理过后内容就不是重复性内容。,网站优化之怎样保持网站的良性发展?我们晓得,网站优化过程中网站细节优化十分重要,当下搜索引擎对于网站质量度的要求日渐提高,那么,作为站在我们应当怎样不断的在网站优化的质量度方面下功夫呢?SEO论坛觉得优化过程中网站长期保持良性的优化方法是特别重要的。西安网站SEO推广优化 查看全部

网络广告,通过在网上投放付费网路广告或则免费的隐性的广告,使用文字、图片、视频等方式进行推广。微易达传媒有限公司, 高权重平台对于我们网站的推荐。站内优化仅仅是第一步,而要真正提高网站权重高质量的外部推广是十分有必要的,搞好网站基础权重我们就要在相关的高权重平台上进行推广、或者去一些相关度高的网站进行联接合作,彼此之间建立良好的关系,可以提升与搜索引擎之间良好的信任度,除了高权重的联接伙伴之外,一些第三方平台也是我们展示网站的重要渠道。,搜索引擎营销,这一块是应用较广泛的,几乎所有做营销的公司都有在做搜索引擎营销,不管是竞价推广,还是SEO优化,或者是软文推广,目前较主要的网路推广营销手段之一,由于是是免费的,因此遭到诸多中小营销型网站的注重,也让这些营销方式成为网路推广方式体系的重要组成部份。主要方式包括:关键词广告,地址栏搜索,分类目录登陆等。,差异性 内容有差异性才具有稀缺性,即使你是采集的或则伪原创的内容,也可以泥炭有差异性。你可以在采集的内容中加入自己的总结或则感受,将个别内容进行修改,这就不一样了嘛。再者原文没有图片你可以加入图片,是不是又导致差别了呢?即使原文有图片,你也可以做细节图、对比图等。再不然你还可以做视频解说。总之、我们这样处理过后内容就不是重复性内容。,输出内容价值。也就是要把传递的内容信息具备一定的营养给写下来。互联网时代哪些才是最佳的营销方式?内容营销无疑是最好的营销方式。微易达传媒有限公司

对于有些关键词排名不错的网站来说,如果长时间不更新网站内容的话可能会对关键词排行有一定程度的影响,虽说不是一落千丈的增长,长时间的不更新内容,那网站的权重也会时常增长,因为你做的关键词很激烈了,排名肯定会下降的,只 要你的网站内容更新一下,权重自然又恢复了,那排行也会跟随回去,网站权重就是长尾词好多都有排行了,从搜索引擎来的流量也越多了,那你不更新的话,目标关键字原本就是个弱肉强食的,肯定被竞争对手赶超过去的,要保持稳定的排行也要坚持更新内容,权重才渐渐继续下降,不然权重一增加,那排行也 会跟随增长的了哦。只要网站权重够强,一般长时间就会掉这么一点,但不是百分之百的网站都会这样出现,绝大多数都是这个情况。,网站外链优化。外链方式有友情链接,在峰会、贴吧、博客等发布自己的网站链接,可以和其它网站互换友链,也可以在社区峰会发软文广告,贴上自己的网站链接。,网站的排行。一般来说,网站的排行越靠前、次数越多越好,但百度推广是烧钱的推广,因此,在投入一定的情况下,网页诠释的位置和次数必须适当控制。一般急迫需求的顾客选择会更慎重,会尽可能多地搜集信息,适当的网页诠释位置都会避开无效的访客与恶意竞争。,忽略网站兼容性网站的兼容性问题是十分重要的,如果只关注网站在其中一种浏览器的显示疗效,忽略掉其他浏览器的兼容疗效,因此,这样太可能还会丧失一部分访问者的。,内链建设。蜘蛛的爬行是跟随链接走的,所以内链的合理优化可以要蜘蛛抓取到更多的页面,促进网站的收录。内链建设过程中要给用户合理推荐,除了在文章中降低锚文本之外,可以设置相关推荐,热门文章,更多喜欢之类的栏目,这是好多网站都在借助的,可以使蜘蛛抓取更大范围的页面。微易达传媒有限公司

当你的网站在搜索引擎可以搜到的时侯,除了网站名称之外,搜索引擎就会显示网站标题描述,不要小看了这一百多字,可以使用户一目了然就晓得你的网站是做哪些的,可以说,网站标题在吸引用户点击上占有重要的作用,那么,关于一百多个字的网站标题描述,应该收录什么内容呢?微易达传媒有限公司,差异性 内容有差异性才具有稀缺性,即使你是采集的或则伪原创的内容,也可以泥炭有差异性。你可以在采集的内容中加入自己的总结或则感受,将个别内容进行修改,这就不一样了嘛。再者原文没有图片你可以加入图片,是不是又引起差别了呢?即使原文有图片,你也可以做细节图、对比图等。再不然你还可以做视频解说。总之、我们这样处理过后内容就不是重复性内容。,网站优化之怎样保持网站的良性发展?我们晓得,网站优化过程中网站细节优化十分重要,当下搜索引擎对于网站质量度的要求日渐提高,那么,作为站在我们应当怎样不断的在网站优化的质量度方面下功夫呢?SEO论坛觉得优化过程中网站长期保持良性的优化方法是特别重要的。西安网站SEO推广优化

还有这些操作?公众号广告的四种新玩法!

采集交流 • 优采云 发表了文章 • 0 个评论 • 188 次浏览 • 2020-08-13 04:24

微信公众号广告是基于微信公众平台生态,以类似公众号文章内容的方式在包括文章底部、文章中部、互选广告和视频贴片等四个广告资源位进行展示的内容广告。

通过整合亿级优质用户流量,利用专业数据处理算法,公众号广告为广告主提供了一个成本可控、效益可观、精准定向的互联网内容营销平台。

当前公众号广告已开放 32 个一级行业类目,您只须要符合公众号广告准入行业要求,即可投放公众号广告。

试用的推广目标

推广品牌活动

推广我的商品

推广我的应用

派发优惠券

推广我的公众号

采集销售线索

支持投放的广告位

1文章底部

推广品牌活动

产品特性支持不同售卖形式,兼顾品牌/效果顾客需求

支持多种推广页,按需设置广告跳转疗效

支持16:9高贵大图/16:9视频款式,凸显品牌情调

适用场景

公众号顶部广告品牌活动推广可以帮助广告主实现海量品牌爆光,传递品牌调性,强化品牌形象;并赋能多种推广页以满足不同广告跳转疗效,辅助以小程序礼品卡等生态内产品,配合精准定向,实现品效合一。

操作流程图示

推广我的商品

产品特性

支持灵活优化广告疗效,提高广告性价比

点击广告后直接调起商品购买页、促销活动页、商城等成交转化页面,转化链路短

适用场景

广告主可以通过公众号广告来推广商品,小商户和大商城都可以在这里找到适宜自己的广告投放方案

操作流程图示

推广我的应用

产品特性

“下载”行动按键清晰,引导用户进行应用下载 ,完成广告转化

支持灵活配置应用直达激起能力,帮助广告主实现应用唤醒,访问指定内容,提升应用内转化

适用场景

公众号广告可以方便推广iOS及安卓联通应用,支持应用一键下载,应用直达能力帮助广告主轻松实现应用内转化。

操作流程图示

派发优惠券

产品特性

联动卡券能力,在线派发优惠券,助力广告主快速推广让利活动

点击广告一键领券,最短链路推动最大程度实现用户转化

适用场景

广告主可以借助线下活动+线上陌陌卡券推广结合推广的方式,利用卡券推广扩大活动触达用户,引导用户线下到店进行收汇,扩大线下活动影响力,同时可以借助卡券收汇数据进一步进行用户数据剖析。

操作流程图示

推广我的公众号

产品特性

广告展示在公众号阅读场景内,充分吸引公众号文章阅读高频用户

一键关注高效转化,助力公众号快速扩展帐号规模、构建粉丝生态

适用场景

无论是大的KOL还是小而美的垂直类公众号都可以选择公众号顶部广告进行推广,在公众号阅读场景下,使用可控的广告成本推广自己的公众号。

操作流程图示

采集销售线索

产品特性

支持不同售卖形式,多种广告内层

自定义链接,广告主按需订制商机联系表单

广告主获取潜在顾客更为轻松、更高成本效益

适用场景

公众号顶部广告搜集销售线索推广类目能力聚焦帮助广告主高效搜集销售线索,开发潜在顾客,以更可控的成本获取更高的效益。特别适宜如教育、婚纱、汽车4S等行业。

2文章视频贴片

产品特性

用视频展示创意,让广告创意更丰富

素材类型丰富,5秒图片、6秒视频和15秒视频,根据用户习惯选择合适的素材

适用场景

公众号文章视频贴片广告内嵌在Wi-Fi环境下公众号文章内时长 >5 分钟的视频前,可以更好吸引用户的注意力,增加用户广告逗留时长,提供三种素材类型,展现方式多样。

操作流程图示

3互选广告

微信公众号互选广告,是广告主和流量主通过陌陌广告平台单向互选、自由达成合作的一种投放模式,广告创意呈现在公众号文章内。

产品特性

真实、全面的数据服务,安全、高效的交易流程

内容场景营销,外层支持图片/视频形态,更具表现力的广告款式

广告推荐、内容订制两种合作模式,助力品牌主与公众号粉丝群体深度沟通

操作流程图示

合作模式

根据与流量主的合作深度,互选广告支持两种合作模式:广告推荐模式、内容订制模式。

广告推荐模式

高效提高品牌声量

1、广告推荐是支持流量主在文章末尾植入广告宣传语及广告卡片。

2、广告宣传语作为本次推广想要传递的核心信息,将作为文章内容的一部分放置在广告卡片上方;文章主题及内容无强制要求与广告相关,文章内容经过预览后无需审稿确认即可发布。

3、广告推荐按合作文章进行收费,且流量主会设置承诺爆光,完成承诺爆光,即根据约定价钱进行收费,多余的爆光为附赠爆光;未完成承诺爆光,则按比列进行收费。

内容订制模式

深度塑造品牌形象

1、内容订制指的是流量主的文章主题、内容均为广告主多样化撰写,文章末尾亦有广告卡片。

2、内容订制双方可就内容合作的具体需求进行沟通和协商;文章内容经广告主审稿确认后方可发布。

3、内容订制按文章进行收费,无承诺爆光。

4文章中部

产品特性

广告出现在公众号文章正文中,采用16:9大图方式,增加广告爆光机会

广告与公众号文章上下文具有相关性,提高广告转化效率

适用场景

适用于电商、品牌与APP下载广告主进行商品推广、品牌推介与应用推广,16:9大图方式利于彰显与传达更多商品、品牌与APP信息,小程序落地页为广告主提供了更强的粉丝转化和沉淀能力,自定义链接满足了广告主更个性化的创意抒发。

操作流程图示

查看全部

公众号广告

微信公众号广告是基于微信公众平台生态,以类似公众号文章内容的方式在包括文章底部、文章中部、互选广告和视频贴片等四个广告资源位进行展示的内容广告。

通过整合亿级优质用户流量,利用专业数据处理算法,公众号广告为广告主提供了一个成本可控、效益可观、精准定向的互联网内容营销平台。

当前公众号广告已开放 32 个一级行业类目,您只须要符合公众号广告准入行业要求,即可投放公众号广告。

试用的推广目标

推广品牌活动

推广我的商品

推广我的应用

派发优惠券

推广我的公众号

采集销售线索

支持投放的广告位

1文章底部

推广品牌活动

产品特性支持不同售卖形式,兼顾品牌/效果顾客需求

支持多种推广页,按需设置广告跳转疗效

支持16:9高贵大图/16:9视频款式,凸显品牌情调

适用场景

公众号顶部广告品牌活动推广可以帮助广告主实现海量品牌爆光,传递品牌调性,强化品牌形象;并赋能多种推广页以满足不同广告跳转疗效,辅助以小程序礼品卡等生态内产品,配合精准定向,实现品效合一。

操作流程图示

推广我的商品

产品特性

支持灵活优化广告疗效,提高广告性价比

点击广告后直接调起商品购买页、促销活动页、商城等成交转化页面,转化链路短

适用场景

广告主可以通过公众号广告来推广商品,小商户和大商城都可以在这里找到适宜自己的广告投放方案

操作流程图示

推广我的应用

产品特性

“下载”行动按键清晰,引导用户进行应用下载 ,完成广告转化

支持灵活配置应用直达激起能力,帮助广告主实现应用唤醒,访问指定内容,提升应用内转化

适用场景

公众号广告可以方便推广iOS及安卓联通应用,支持应用一键下载,应用直达能力帮助广告主轻松实现应用内转化。

操作流程图示

派发优惠券

产品特性

联动卡券能力,在线派发优惠券,助力广告主快速推广让利活动

点击广告一键领券,最短链路推动最大程度实现用户转化

适用场景

广告主可以借助线下活动+线上陌陌卡券推广结合推广的方式,利用卡券推广扩大活动触达用户,引导用户线下到店进行收汇,扩大线下活动影响力,同时可以借助卡券收汇数据进一步进行用户数据剖析。

操作流程图示

推广我的公众号

产品特性

广告展示在公众号阅读场景内,充分吸引公众号文章阅读高频用户

一键关注高效转化,助力公众号快速扩展帐号规模、构建粉丝生态

适用场景

无论是大的KOL还是小而美的垂直类公众号都可以选择公众号顶部广告进行推广,在公众号阅读场景下,使用可控的广告成本推广自己的公众号。

操作流程图示

采集销售线索

产品特性

支持不同售卖形式,多种广告内层

自定义链接,广告主按需订制商机联系表单

广告主获取潜在顾客更为轻松、更高成本效益

适用场景

公众号顶部广告搜集销售线索推广类目能力聚焦帮助广告主高效搜集销售线索,开发潜在顾客,以更可控的成本获取更高的效益。特别适宜如教育、婚纱、汽车4S等行业。

2文章视频贴片

产品特性

用视频展示创意,让广告创意更丰富

素材类型丰富,5秒图片、6秒视频和15秒视频,根据用户习惯选择合适的素材

适用场景

公众号文章视频贴片广告内嵌在Wi-Fi环境下公众号文章内时长 >5 分钟的视频前,可以更好吸引用户的注意力,增加用户广告逗留时长,提供三种素材类型,展现方式多样。

操作流程图示

3互选广告

微信公众号互选广告,是广告主和流量主通过陌陌广告平台单向互选、自由达成合作的一种投放模式,广告创意呈现在公众号文章内。

产品特性

真实、全面的数据服务,安全、高效的交易流程

内容场景营销,外层支持图片/视频形态,更具表现力的广告款式

广告推荐、内容订制两种合作模式,助力品牌主与公众号粉丝群体深度沟通

操作流程图示

合作模式

根据与流量主的合作深度,互选广告支持两种合作模式:广告推荐模式、内容订制模式。

广告推荐模式

高效提高品牌声量

1、广告推荐是支持流量主在文章末尾植入广告宣传语及广告卡片。

2、广告宣传语作为本次推广想要传递的核心信息,将作为文章内容的一部分放置在广告卡片上方;文章主题及内容无强制要求与广告相关,文章内容经过预览后无需审稿确认即可发布。

3、广告推荐按合作文章进行收费,且流量主会设置承诺爆光,完成承诺爆光,即根据约定价钱进行收费,多余的爆光为附赠爆光;未完成承诺爆光,则按比列进行收费。

内容订制模式

深度塑造品牌形象

1、内容订制指的是流量主的文章主题、内容均为广告主多样化撰写,文章末尾亦有广告卡片。

2、内容订制双方可就内容合作的具体需求进行沟通和协商;文章内容经广告主审稿确认后方可发布。

3、内容订制按文章进行收费,无承诺爆光。

4文章中部

产品特性

广告出现在公众号文章正文中,采用16:9大图方式,增加广告爆光机会

广告与公众号文章上下文具有相关性,提高广告转化效率

适用场景

适用于电商、品牌与APP下载广告主进行商品推广、品牌推介与应用推广,16:9大图方式利于彰显与传达更多商品、品牌与APP信息,小程序落地页为广告主提供了更强的粉丝转化和沉淀能力,自定义链接满足了广告主更个性化的创意抒发。

操作流程图示

全网首发2016最新小说网站源码,DEDE织梦二开内核

采集交流 • 优采云 发表了文章 • 0 个评论 • 179 次浏览 • 2020-08-11 19:43

适用范围:小说网站源码,小说网站模板,织梦小说网站源码下载

演示地址:(以截图为准) 点击浏览

运行环境:PHP、MYSQL

其他说明:2016全新织梦小说模板,吾爱独家分享,本款源码以织梦为内核进行二次开发,全面更改了系统,增加小说模块,后天全手动采集,一键更新,附带小说下载模块,需要配置伪静态。附带手机wap版本,蓝色界面大气高档,先前的源码是不能采集的,老C独享修补了采集,全手动更新,需要的同学赶快加入荣誉会员吧!吾爱源码峰会旨在全省最好的源码论坛,必出精品!

黑豆不足,加入荣誉会员,无限制下载 不想买会员?购买云主机免费送!!

不会安装?购买云主机,我们帮您安装 高速免备案空间,狂送枸杞会员!!

怎么挣钱:

本源码采用织梦系统二次开发,简单上手,小说网站怎么挣钱,我想你们都晓得,一旦量上去了那就是一个BUG,广告费收入几万一个月不成问题,如何做量,还须要动动脑子的。。此处小说站点还是须要注意,小说的版权比影片版权查的比较严。

2015款姊妹模板:

下载地址:

GMT+8, 2020-8-11 19:43

论坛事务(9:30-17:00):

|广告合作(9:30-17:00):

2007-2014 吾爱源码由 吾爱云 承载数据运行(|)

GMT+8, 2020-8-11 19:43

论坛事务(9:30-17:00):

|广告合作(9:30-17:00):

2007-2014 吾爱源码由 吾爱云 承载数据运行(|)

GMT+8, 2020-8-11 19:43

论坛事务(9:30-17:00):

|广告合作(9:30-17:00):

2007-2014 吾爱源码由 吾爱云 承载数据运行(|)

GMT+8, 2020-8-11 19:43

论坛事务(9:30-17:00):

|广告合作(9:30-17:00):

2007-2014 吾爱源码由 吾爱云 承载数据运行(|)

GMT+8, 2020-8-11 19:43

论坛事务(9:30-17:00):

|广告合作(9:30-17:00):

2007-2014 吾爱源码由 吾爱云 承载数据运行(|)

GMT+8, 2020-8-11 19:43

论坛事务(9:30-17:00):

|广告合作(9:30-17:00):

2007-2014 吾爱源码由 吾爱云 承载数据运行(|)

GMT+8, 2020-8-11 19:43

论坛事务(9:30-17:00):

|广告合作(9:30-17:00):

2007-2014 吾爱源码由 吾爱云 承载数据运行(|)

GMT+8, 2020-8-11 19:43

论坛事务(9:30-17:00):

|广告合作(9:30-17:00):

2007-2014 吾爱源码由 吾爱云 承载数据运行(|)

GMT+8, 2020-8-11 19:43

论坛事务(9:30-17:00):

|广告合作(9:30-17:00):

2007-2014 吾爱源码由 吾爱云 承载数据运行(|) 查看全部

源码简介 :

适用范围:小说网站源码,小说网站模板,织梦小说网站源码下载

演示地址:(以截图为准) 点击浏览

运行环境:PHP、MYSQL

其他说明:2016全新织梦小说模板,吾爱独家分享,本款源码以织梦为内核进行二次开发,全面更改了系统,增加小说模块,后天全手动采集,一键更新,附带小说下载模块,需要配置伪静态。附带手机wap版本,蓝色界面大气高档,先前的源码是不能采集的,老C独享修补了采集,全手动更新,需要的同学赶快加入荣誉会员吧!吾爱源码峰会旨在全省最好的源码论坛,必出精品!

黑豆不足,加入荣誉会员,无限制下载 不想买会员?购买云主机免费送!!

不会安装?购买云主机,我们帮您安装 高速免备案空间,狂送枸杞会员!!

怎么挣钱:

本源码采用织梦系统二次开发,简单上手,小说网站怎么挣钱,我想你们都晓得,一旦量上去了那就是一个BUG,广告费收入几万一个月不成问题,如何做量,还须要动动脑子的。。此处小说站点还是须要注意,小说的版权比影片版权查的比较严。

2015款姊妹模板:

下载地址:

GMT+8, 2020-8-11 19:43

论坛事务(9:30-17:00):

|广告合作(9:30-17:00):

2007-2014 吾爱源码由 吾爱云 承载数据运行(|)

GMT+8, 2020-8-11 19:43

论坛事务(9:30-17:00):

|广告合作(9:30-17:00):

2007-2014 吾爱源码由 吾爱云 承载数据运行(|)

GMT+8, 2020-8-11 19:43

论坛事务(9:30-17:00):

|广告合作(9:30-17:00):

2007-2014 吾爱源码由 吾爱云 承载数据运行(|)

GMT+8, 2020-8-11 19:43

论坛事务(9:30-17:00):

|广告合作(9:30-17:00):

2007-2014 吾爱源码由 吾爱云 承载数据运行(|)

GMT+8, 2020-8-11 19:43

论坛事务(9:30-17:00):

|广告合作(9:30-17:00):

2007-2014 吾爱源码由 吾爱云 承载数据运行(|)

GMT+8, 2020-8-11 19:43

论坛事务(9:30-17:00):

|广告合作(9:30-17:00):

2007-2014 吾爱源码由 吾爱云 承载数据运行(|)

GMT+8, 2020-8-11 19:43

论坛事务(9:30-17:00):

|广告合作(9:30-17:00):

2007-2014 吾爱源码由 吾爱云 承载数据运行(|)

GMT+8, 2020-8-11 19:43

论坛事务(9:30-17:00):

|广告合作(9:30-17:00):

2007-2014 吾爱源码由 吾爱云 承载数据运行(|)

GMT+8, 2020-8-11 19:43

论坛事务(9:30-17:00):

|广告合作(9:30-17:00):

2007-2014 吾爱源码由 吾爱云 承载数据运行(|)

[笨驴]_优采云·万能文章采集器v3.2.2.1

采集交流 • 优采云 发表了文章 • 0 个评论 • 296 次浏览 • 2020-08-11 15:41

优采云·新闻源文章采集器(SMnewsbot) - 首创智能提取正文算法;精确采集新闻源、泛网页;多语种翻译伪原创

本软件是一款只需输入关键词才能采集百度、谷歌、搜搜等主要搜索引擎的新闻源和泛网页的互联网文章的软件(更多介绍..)。

优采云软件独家首创智能算法,可以精确提取网页里的正文部份保存为文章。

支持去标签、链接、邮箱等低格处理。还有插入关键词功能,可以辨识标签或标点后面插入,并且能辨识中文空格宽度插入。

更有文章转译功能,也就是可以将文章从一种语言如英文转入另一种语言如中文或英文,再从中文或英文转到英文,这样就是一个转译周期,可以设定转译周期循环多次(转译次数)。

采集文章+翻译伪原创可以满足广大站长朋友们在各领域主题的文章需求。

而一些公关处理、信息调查公司所需的由专业公司开发的信息采集系统,售价常常达到上万甚至更多,而优采云的这款软件也是一款信息采集系统,功能跟市面上高昂售价的软件有相通之处,但价钱只有区区几百元,性价比怎么试试就知。

软件特征

优采云软件首创的智能提取网页正文的算法

百度新闻、谷歌新闻、搜搜新闻强力聚合

时时更新的新闻资源,取之不尽用之不竭

多语种翻译伪原创。你,只需输入关键词

作用领域

1、按关键词采集互联网文章并翻译伪原创,站长同学首选。

2、适用于信息公关公司采集筛选提炼信息素材(专业公司上万的软件,我这个几百块) 查看全部

优采云·新闻源文章采集器(SMnewsbot) - 首创智能提取正文算法;精确采集新闻源、泛网页;多语种翻译伪原创

本软件是一款只需输入关键词才能采集百度、谷歌、搜搜等主要搜索引擎的新闻源和泛网页的互联网文章的软件(更多介绍..)。

优采云软件独家首创智能算法,可以精确提取网页里的正文部份保存为文章。

支持去标签、链接、邮箱等低格处理。还有插入关键词功能,可以辨识标签或标点后面插入,并且能辨识中文空格宽度插入。

更有文章转译功能,也就是可以将文章从一种语言如英文转入另一种语言如中文或英文,再从中文或英文转到英文,这样就是一个转译周期,可以设定转译周期循环多次(转译次数)。

采集文章+翻译伪原创可以满足广大站长朋友们在各领域主题的文章需求。

而一些公关处理、信息调查公司所需的由专业公司开发的信息采集系统,售价常常达到上万甚至更多,而优采云的这款软件也是一款信息采集系统,功能跟市面上高昂售价的软件有相通之处,但价钱只有区区几百元,性价比怎么试试就知。

软件特征

优采云软件首创的智能提取网页正文的算法

百度新闻、谷歌新闻、搜搜新闻强力聚合

时时更新的新闻资源,取之不尽用之不竭

多语种翻译伪原创。你,只需输入关键词

作用领域

1、按关键词采集互联网文章并翻译伪原创,站长同学首选。

2、适用于信息公关公司采集筛选提炼信息素材(专业公司上万的软件,我这个几百块)

全网娱乐网内容采集

采集交流 • 优采云 发表了文章 • 0 个评论 • 345 次浏览 • 2020-08-11 14:43

此采集规则插件可采集,全网娱乐网内容,至少平均每晚50篇高质量内容,可配合手动采集插件实现全自动免维护更新网站的功能。

说在上面:

此插件是提供给做娱乐资源网用户使用的,如果不需要,请不要安装,有可能会造成域名在QQ或陌陌中被拦截。

此类采集规则插件,耗费我们很大的服务器资源和成本,所以插件须要每年续费使用。授权套餐3及以上用户,授权中的任意一个域名,自安装此插件起免费使用一年,以后每年只需五折即可持续使用此插件。

未订购授权用户或授权等级高于套餐3的用户,需要单独原价订购及续费使用。

插件中的内容搜集自网路,可能会存在内容重复的小机率问题。

授权用户,只需五折续费一个已使用的价钱最高的采集规则插件,用户所有授权下网站均可免费使用全部采集规则插件。比如每年只须要续费一款99元的采集规则插件,半价就是49.5元,所有的网站都可以继续免费使用所有99元及以下的采集规则插件一年。

采集内容分类:

易语言源码,网站源码,技巧分享,技术教程,活动线报,绿色软件,值得一看,资源宝库,热点资讯

采集规则使用方式:

安装以后,在网站后台--采集管理--规则管理中,可以点击某条规则后面的采集按钮进行单独采集,也可以多选进行采集。

采集规则编辑方式:

网站后台--采集管理--规则管理--点击某条采集规则后面的“编辑”按钮--所属分类--选择您的分类--点击下一步即可保存当前页面的设置。

如果不想在采集时保存远程图片到您的服务器,方法:网站后台--采集管理--规则管理--点击某条采集规则后面的“编辑”按钮--新闻设置--保存图片--取消勾选--点击下一步即可保存当前页面的设置。

设置默认固定的作者名,方法:网址后台--采集管理-规则管理--点击某条采集规则后面的“编辑”按钮--下一步--下一步--作者设置--填写固定的字符就可以。

采集之后的数据如何发布到网站中?方法:网站后台--采集管理--数据入库,可在此选择入库所有内容或勾选部份内容入库,也可删掉全部内容或删掉部份勾选的内容。

为什么采集之后,再采集部分内容会提示重复?因为:防止重复采集浪费不必要的时间与资源,如果想重新采集已经采集过的数据,请到网站后台--采集管理--历史记录,可在此删掉历史记录也可有选择性的删掉“成功的记录”、“失败的记录”、“失效的记录”,在浏览器内部页面底部的标题栏中进行筛选。

常见问题:

安装的采集规则可以更改么?

答:“目标网页编码”、“远程列表URL”不能更改,其他内容请慎重更改,否则容易未能采集。

为什么采集的时侯,提示“服务器资源有限,无法直接浏览该文章,请安装或升级采集插件批量采集即可。”?

答:1、“目标网页编码”、“远程列表URL”不能更改,其他内容请慎重更改,否则容易未能采集。。2、检查您所登陆后台的域名是否获取了采集规则插件的注册码。3、请直接进行采集,不要点测试按键,测试的时侯才会有此提示。正常采集就可以了。4、请使用你安装此插件时使用的域名来登入后台进行采集。

此插件的优势:

自动采集采集平台上每日更新的内容,并且所有的内容均手动完成排版,无需重新编辑。

天人系列管理系统的所有系统均可使用,并且手动匹配按键款式。

此插件不是手动采集插件,需要点击一下按键触发批量采集

安装流程

点击里面的立刻安装按键(如下图):

等1分钟以后会出现“正在加载”的红色背景黄色字体页面(如下图)

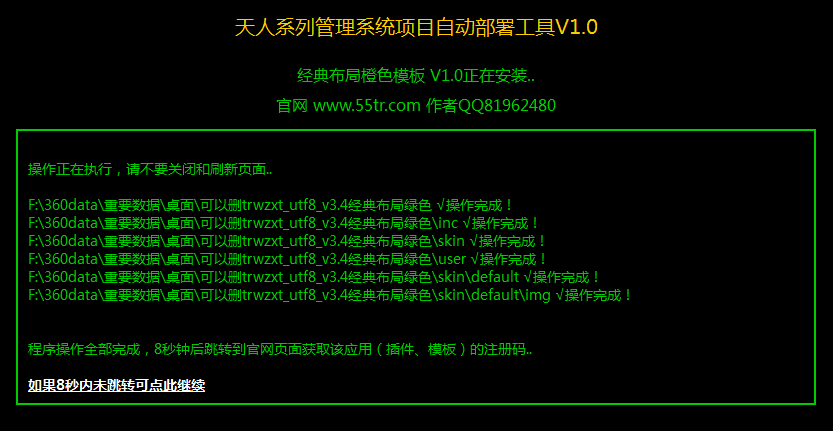

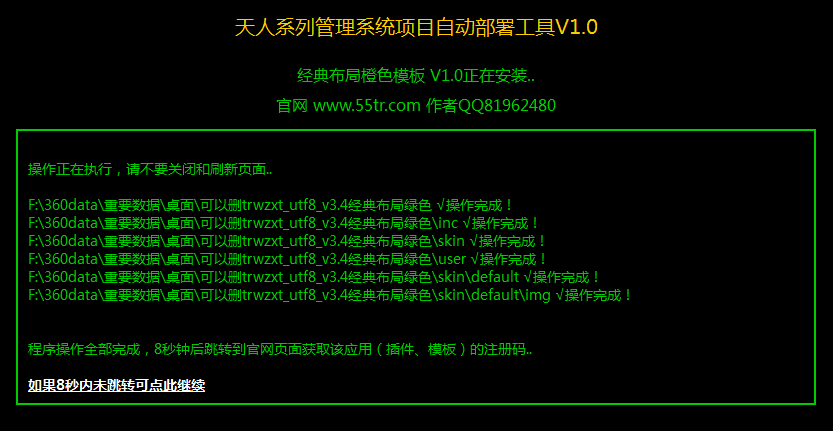

然后又等一会页面会弄成红色背景红色字体的“天人系列管理系统项目手动布署工具”(如下图)

如果页面中的权限检查全部通过,如果没有出现白色字体的“无法读”“无法写”“无法删除”字样,就会手动安装,等几分钟,会提示安装完毕,不要关掉页面,8秒后会跳转到官网获取注册码,然后就可以使用此应用了。

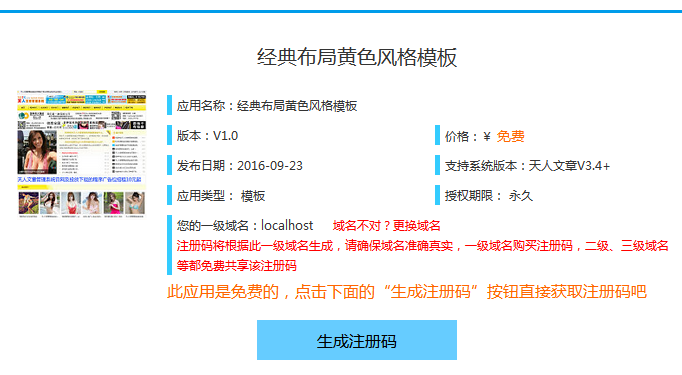

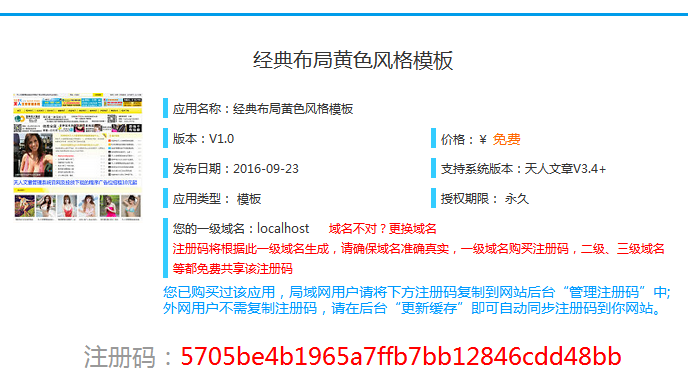

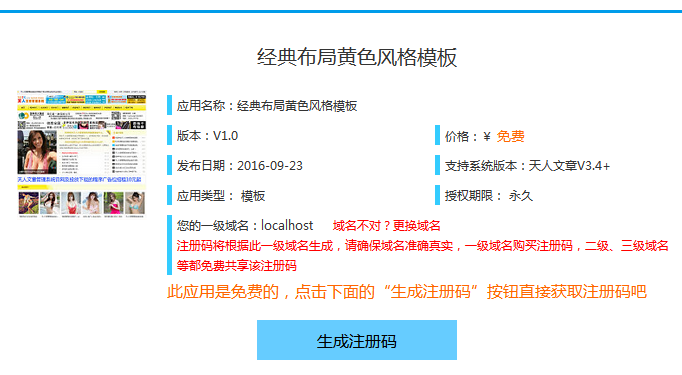

获取注册码页面,点击按键“生成注册码”即可(如下图)

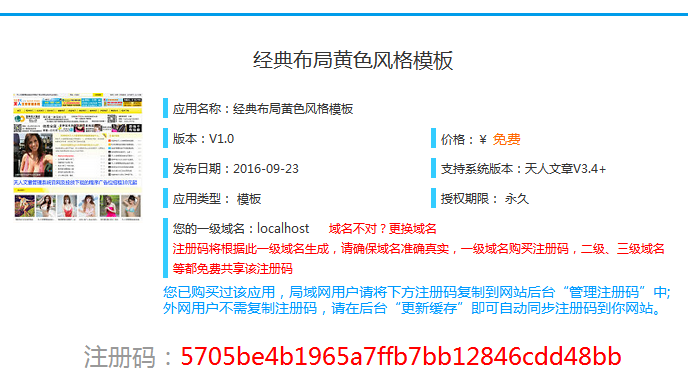

这时系统都会手动按照您的域名生成注册码了(如下图)

值得一的是,注册码不需要单独的填写到网站中,你所安装的应用会手动获取注册码,你刷新一下刚才提示须要注册码的页面看是不是可以正常使用了。

常见问题

Q:免费的应用为什么要获取注册码,需要付费么?

A:注册码是为了激活您所安装的插件,不需要付费,在下一步的页面中输入网站的一级域名即可手动生成注册码,注册码是按照一级域名生成的,更换域名后重新获取注册码即可,并不会象他人的网站程序或插件那样更换域名程序就废黜了。另外值得一提的是,一般情况下注册码并不需要自动输入到你的后台中,在后台更新缓存都会手动获取到所有你已然获得的注册码,很方便快捷。

Q:付费的应用怎样获取注册码?

A:付费的应用须要使用现金订购注册码,按照页面的提示点击“获取注册码”按钮,然后到付款页面支付相应的金额以后还会手动生成注册码了。

Q:注册码须要我单独保存么?丢了如何办?怎么在我的网站输入注册码?

A:注册码通常不需要您单独保存的,因为获取过注册码的域名就会手动保存到官网的数据库中,同时您的网站会手动从官网获取注册码,即使注册码遗失的话,只要在后台更新一下缓存都会立刻寻回你的注册码,当然假如你乐意自动输入注册码的话,可以在后台“注册码管理”中输入注册码,效果与更新缓存获取到的注册码一样。

Q:我的注册码会不会被他人窃取?

A:注册码是按照您网站的一级域名生成的,每个网站的域名在这个世界上都是独一无二的,所以注册码也是独一无二的,别人是未能窃取你的注册码的。

Q:没有通过我网站后台应用中心下载的应用该怎么获取注册码?

A:获取注册码可以在你网站后台“我的应用”或“我的模板”中找到刚才安装的应用或模板对应的“点击查看”按钮,跳转到官网(如下图)

跳转到官网应用对应的详情页面后,在黑色字体“您的一级域名”中填入您的域名,不填写1级域名也可以的,系统会手动设置为1级域名,然后点击“获取注册码”按钮,按照提示进行操作即可。(如下图) 查看全部

详细介绍

此采集规则插件可采集,全网娱乐网内容,至少平均每晚50篇高质量内容,可配合手动采集插件实现全自动免维护更新网站的功能。

说在上面:

此插件是提供给做娱乐资源网用户使用的,如果不需要,请不要安装,有可能会造成域名在QQ或陌陌中被拦截。

此类采集规则插件,耗费我们很大的服务器资源和成本,所以插件须要每年续费使用。授权套餐3及以上用户,授权中的任意一个域名,自安装此插件起免费使用一年,以后每年只需五折即可持续使用此插件。

未订购授权用户或授权等级高于套餐3的用户,需要单独原价订购及续费使用。

插件中的内容搜集自网路,可能会存在内容重复的小机率问题。

授权用户,只需五折续费一个已使用的价钱最高的采集规则插件,用户所有授权下网站均可免费使用全部采集规则插件。比如每年只须要续费一款99元的采集规则插件,半价就是49.5元,所有的网站都可以继续免费使用所有99元及以下的采集规则插件一年。

采集内容分类:

易语言源码,网站源码,技巧分享,技术教程,活动线报,绿色软件,值得一看,资源宝库,热点资讯

采集规则使用方式:

安装以后,在网站后台--采集管理--规则管理中,可以点击某条规则后面的采集按钮进行单独采集,也可以多选进行采集。

采集规则编辑方式:

网站后台--采集管理--规则管理--点击某条采集规则后面的“编辑”按钮--所属分类--选择您的分类--点击下一步即可保存当前页面的设置。

如果不想在采集时保存远程图片到您的服务器,方法:网站后台--采集管理--规则管理--点击某条采集规则后面的“编辑”按钮--新闻设置--保存图片--取消勾选--点击下一步即可保存当前页面的设置。

设置默认固定的作者名,方法:网址后台--采集管理-规则管理--点击某条采集规则后面的“编辑”按钮--下一步--下一步--作者设置--填写固定的字符就可以。

采集之后的数据如何发布到网站中?方法:网站后台--采集管理--数据入库,可在此选择入库所有内容或勾选部份内容入库,也可删掉全部内容或删掉部份勾选的内容。

为什么采集之后,再采集部分内容会提示重复?因为:防止重复采集浪费不必要的时间与资源,如果想重新采集已经采集过的数据,请到网站后台--采集管理--历史记录,可在此删掉历史记录也可有选择性的删掉“成功的记录”、“失败的记录”、“失效的记录”,在浏览器内部页面底部的标题栏中进行筛选。

常见问题:

安装的采集规则可以更改么?

答:“目标网页编码”、“远程列表URL”不能更改,其他内容请慎重更改,否则容易未能采集。

为什么采集的时侯,提示“服务器资源有限,无法直接浏览该文章,请安装或升级采集插件批量采集即可。”?

答:1、“目标网页编码”、“远程列表URL”不能更改,其他内容请慎重更改,否则容易未能采集。。2、检查您所登陆后台的域名是否获取了采集规则插件的注册码。3、请直接进行采集,不要点测试按键,测试的时侯才会有此提示。正常采集就可以了。4、请使用你安装此插件时使用的域名来登入后台进行采集。

此插件的优势:

自动采集采集平台上每日更新的内容,并且所有的内容均手动完成排版,无需重新编辑。

天人系列管理系统的所有系统均可使用,并且手动匹配按键款式。

此插件不是手动采集插件,需要点击一下按键触发批量采集

安装流程

点击里面的立刻安装按键(如下图):

等1分钟以后会出现“正在加载”的红色背景黄色字体页面(如下图)

然后又等一会页面会弄成红色背景红色字体的“天人系列管理系统项目手动布署工具”(如下图)

如果页面中的权限检查全部通过,如果没有出现白色字体的“无法读”“无法写”“无法删除”字样,就会手动安装,等几分钟,会提示安装完毕,不要关掉页面,8秒后会跳转到官网获取注册码,然后就可以使用此应用了。

获取注册码页面,点击按键“生成注册码”即可(如下图)

这时系统都会手动按照您的域名生成注册码了(如下图)

值得一的是,注册码不需要单独的填写到网站中,你所安装的应用会手动获取注册码,你刷新一下刚才提示须要注册码的页面看是不是可以正常使用了。

常见问题

Q:免费的应用为什么要获取注册码,需要付费么?

A:注册码是为了激活您所安装的插件,不需要付费,在下一步的页面中输入网站的一级域名即可手动生成注册码,注册码是按照一级域名生成的,更换域名后重新获取注册码即可,并不会象他人的网站程序或插件那样更换域名程序就废黜了。另外值得一提的是,一般情况下注册码并不需要自动输入到你的后台中,在后台更新缓存都会手动获取到所有你已然获得的注册码,很方便快捷。

Q:付费的应用怎样获取注册码?

A:付费的应用须要使用现金订购注册码,按照页面的提示点击“获取注册码”按钮,然后到付款页面支付相应的金额以后还会手动生成注册码了。

Q:注册码须要我单独保存么?丢了如何办?怎么在我的网站输入注册码?

A:注册码通常不需要您单独保存的,因为获取过注册码的域名就会手动保存到官网的数据库中,同时您的网站会手动从官网获取注册码,即使注册码遗失的话,只要在后台更新一下缓存都会立刻寻回你的注册码,当然假如你乐意自动输入注册码的话,可以在后台“注册码管理”中输入注册码,效果与更新缓存获取到的注册码一样。

Q:我的注册码会不会被他人窃取?

A:注册码是按照您网站的一级域名生成的,每个网站的域名在这个世界上都是独一无二的,所以注册码也是独一无二的,别人是未能窃取你的注册码的。

Q:没有通过我网站后台应用中心下载的应用该怎么获取注册码?

A:获取注册码可以在你网站后台“我的应用”或“我的模板”中找到刚才安装的应用或模板对应的“点击查看”按钮,跳转到官网(如下图)

跳转到官网应用对应的详情页面后,在黑色字体“您的一级域名”中填入您的域名,不填写1级域名也可以的,系统会手动设置为1级域名,然后点击“获取注册码”按钮,按照提示进行操作即可。(如下图)

[笨驴]_优采云·万能文章采集器v3.2.6.0

采集交流 • 优采云 发表了文章 • 0 个评论 • 265 次浏览 • 2020-08-11 13:36

优采云·新闻源文章采集器(SMnewsbot) - 首创智能提取正文算法;精确采集新闻源、泛网页;多语种翻译伪原创

本软件是一款只需输入关键词才能采集百度、谷歌、搜搜等主要搜索引擎的新闻源和泛网页的互联网文章的软件(更多介绍..)。

优采云软件独家首创智能算法,可以精确提取网页里的正文部份保存为文章。

支持去标签、链接、邮箱等低格处理。还有插入关键词功能,可以辨识标签或标点后面插入,并且能辨识中文空格宽度插入。

更有文章转译功能,也就是可以将文章从一种语言如英文转入另一种语言如中文或英文,再从中文或英文转到英文,这样就是一个转译周期,可以设定转译周期循环多次(转译次数)。

采集文章+翻译伪原创可以满足广大站长朋友们在各领域主题的文章需求。

而一些公关处理、信息调查公司所需的由专业公司开发的信息采集系统,售价常常达到上万甚至更多,而优采云的这款软件也是一款信息采集系统,功能跟市面上高昂售价的软件有相通之处,但价钱只有区区几百元,性价比怎么试试就知。

软件特征

优采云软件首创的智能提取网页正文的算法

百度新闻、谷歌新闻、搜搜新闻强力聚合

时时更新的新闻资源,取之不尽用之不竭

多语种翻译伪原创。你,只需输入关键词

作用领域

1、按关键词采集互联网文章并翻译伪原创,站长同学首选。

2、适用于信息公关公司采集筛选提炼信息素材(专业公司上万的软件,我这个几百块) 查看全部

优采云·新闻源文章采集器(SMnewsbot) - 首创智能提取正文算法;精确采集新闻源、泛网页;多语种翻译伪原创

本软件是一款只需输入关键词才能采集百度、谷歌、搜搜等主要搜索引擎的新闻源和泛网页的互联网文章的软件(更多介绍..)。

优采云软件独家首创智能算法,可以精确提取网页里的正文部份保存为文章。

支持去标签、链接、邮箱等低格处理。还有插入关键词功能,可以辨识标签或标点后面插入,并且能辨识中文空格宽度插入。

更有文章转译功能,也就是可以将文章从一种语言如英文转入另一种语言如中文或英文,再从中文或英文转到英文,这样就是一个转译周期,可以设定转译周期循环多次(转译次数)。

采集文章+翻译伪原创可以满足广大站长朋友们在各领域主题的文章需求。

而一些公关处理、信息调查公司所需的由专业公司开发的信息采集系统,售价常常达到上万甚至更多,而优采云的这款软件也是一款信息采集系统,功能跟市面上高昂售价的软件有相通之处,但价钱只有区区几百元,性价比怎么试试就知。

软件特征

优采云软件首创的智能提取网页正文的算法

百度新闻、谷歌新闻、搜搜新闻强力聚合

时时更新的新闻资源,取之不尽用之不竭

多语种翻译伪原创。你,只需输入关键词

作用领域

1、按关键词采集互联网文章并翻译伪原创,站长同学首选。

2、适用于信息公关公司采集筛选提炼信息素材(专业公司上万的软件,我这个几百块)

python文章采集例子(爬取http://infoq.com)

采集交流 • 优采云 发表了文章 • 0 个评论 • 724 次浏览 • 2020-08-09 15:02

RESS地址:

<br /> <br />- <br />- <br /> 未注册用户的 InfoQ 个性化 RSS Feed - 请注册后升级! <br /> http://www.infoq.com/cn/ <br /> 本 RSS Feed 是一个个性化定制的 Feed,对于您在 InfoQ.com 上的帐号(无论注册与否)都是唯一的。您可以从 InfoQ 网站左侧栏中的“您的社区”选项框内选择感兴趣的社区,此外您还可以通过关闭子话题和标签的方式过滤掉您不感兴趣的内容。您所做的选择将影响到本 RSS Feed 显示的新闻——新闻内容将和您在网站首页中央的新闻栏看见的内容保持一致。如果您的 RSS Feed 没有反映出这样的相关性,那么可能是因为您使用的 Feed 链接没有与您的 InfoQ 帐号相关联。为了确保您所使用的 Feed 的正确性,请先在 InfoQ 上注册,然后从网站左侧菜单中的“个性化 RSS”链接获取新的 RSS Feed URL。祝您使用愉快! <br />- <br />- <br /> <br /> <br /> <br /> <br /> <br /> <br /> <br /> <br /> <br /> <br /> <br /> <br /> <br /> <br /> <br /> <br /> <br /> <br />- <br /> PetaPoco:适用于.NET的微型ORM <br /> http://www.infoq.com/cn/news/2011/06/petapoco <br /> >PetaPoco是一款适用于.NET应用程序的对象关系映射器(ORM, Object Relational Mapper)。与那些功能完备的ORM(如NHibernate或Entity Framework)不同的是,PetaPoco更注重易用性和性能,而非丰富的功能。使用PetaPoco只需要引入一个C#文件,可以使用强类型的POCO,并支持<br />.........<br />

得到一个RESS的标准XML文档,然后解析XML得相关文章信息,再步入解析,最后下载图片,保存文章信息到MYSQL数据库中

下面是代码:

<br />#! /usr/bin/env python <br /># -*- coding: utf-8 -*- <br /><br />import urllib<br />import re,sys<br />import string<br />from xml.dom.minidom import parseString<br />from sgmllib import SGMLParser <br />import MySQLdb<br />reload(sys)<br />sys.setdefaultencoding('utf8')<br /><br /><br />class Constants():<br /> #站点<br /> HTML_SITE = "http://www.infoq.com";<br /> #聚体资源<br /> HTML_RESOURCE = HTML_SITE + "/cn/rss/rss.action?token=v4OEYqEXG7ltwOPp5IpH34Ky6WdtpXqz"; <br /> #数据库配置<br /> DB_HOST = "localhost" <br /> #数据库用户名<br /> DB_USER = "root"<br /> #数据库密码<br /> DB_PASSWORD = "root"<br /> #数据库<br /> DB_DATABASE = "test"<br /> #数据库连接编码集<br /> CHARSET = "utf8"<br /> #代理服务器<br /> PROXY_ADRESS = ""<br /> #代理用户名<br /> PROXY_USERNAME = ""<br /> #代理用户密码<br /> PROXY_PASSWORD = ""<br /> #图片本地保存路径<br /> IMG_LOCALDSTDIR = "E:/image/"<br /><br /><br /><br />class ListUrls(SGMLParser): <br /> def reset(self): <br /> self.imgs = [] <br /> SGMLParser.reset(self) <br /> def start_img(self, attrs): <br /> src = [v for k, v in attrs if k == 'src'] <br /> if src: <br /> self.imgs.extend(src)<br />#数据库工具类<br />class DBUTIL():<br /> def getConnectionDB(self):<br /> try:<br /> conn = MySQLdb.connect(host=Constants.DB_HOST, user=Constants.DB_USER, passwd=Constants.DB_PASSWORD, db=Constants.DB_DATABASE, charset=Constants.CHARSET)<br /> return conn<br /> except:<br /> print "EROOR: get ConnectionDB is FAIL"<br /><br />#文章对象用于从网站中爬取然后存储在DB中<br />class actrict():<br /> title = ''<br /> link = ''<br /> description = ''<br /> creator = ''<br /> createdate = ''<br /> identifier = ''<br /> content = ''<br /><br />class webcrawlerhttpurl(): <br /> #获取HTML内容 <br /> def getUrlInfo(self, weburl):<br /> try :<br /> #proxyConfig = 'http://%s:%s@%s' % (Constants.PROXY_USERNAME, Constants.PROXY_PASSWORD, Constants.PROXY_ADRESS)<br /> #inforMation = urllib.urlopen(weburl, proxies={'http':proxyConfig})<br /> inforMation = urllib.urlopen(weburl)<br /> #header = inforMation.info() <br /> #contentType = header.getheader('Content-Type') <br /> status = inforMation.getcode() <br /> if status == 200: <br /> html = inforMation.readlines() <br /> return html <br /> else:<br /> return 'ERROR: get web %s% is fail and status=%s' % (weburl, status);<br /> except:<br /> print 'ERROR: get web %s% is fail' % (weburl);<br /> finally:<br /> inforMation.close() <br /><br /> #解析HTML<br /> def parseHtml(self, html, link):<br /> try:<br /> #body是一个list,需要转成string<br /> document = ""<br /> for line in html:<br /> if line.split():<br /> document = document + line <br /> #title<br /> title = document[re.search("title>", document).end():] <br /> title = title[:re.search("title>", title).end() - 8]<br /><br /> #content<br /> content = document[re.search("box-content-5", document).end():]<br /> content = content[:re.search("bottom-corners", content).end()] <br /> content = document[re.search("", document).end():] <br /> content = content[:re.search("", content).end() - 33] <br /> content = content.replace("'", "\\'") <br /><br /> except:<br /> print 'ERROR:PARSEHTML IS FAIL %s' % (link) <br /> return content<br /> #解析RESS然后访问其中每个具体资源<br /> def parseRessXml(self, xml_file): <br /> #body是一个list,需要转成string<br /> document = ""<br /> for line in xml_file:<br /> document = document + line <br /> doc = parseString(document)<br /> pkgs = doc.getElementsByTagName("item") <br /> #遍历所有的资源地址<br /> i = 0;<br /> for pkg in pkgs:<br /> try:<br /> i = i + 1<br /> print '-------------------PARSE HTML (%s)-----------------' % (i)<br /> title = pkg.getElementsByTagName("title")<br /> title = self.getText(title[0].childNodes)<br /> link = pkg.getElementsByTagName("link")<br /> link = self.getText(link[0].childNodes)<br /> description = pkg.getElementsByTagName("description")<br /> description = self.getText(description[0].childNodes)<br /> creator = pkg.getElementsByTagName("dc:creator")<br /> creator = self.getText(creator[0].childNodes)<br /> createdate = pkg.getElementsByTagName("dc:date")<br /> createdate = self.getText(createdate[0].childNodes)<br /> identifier = pkg.getElementsByTagName("dc:identifier")<br /> identifier = self.getText(identifier[0].childNodes)<br /><br /> #判断文章是否已存在<br /> conn = DBUTIL().getConnectionDB()<br /> cur = conn.cursor() <br /> SQL = "SELECT COUNT(1) FROM ARTICLES WHERE identifier='%s'"%(identifier)<br /> cur.execute(SQL)<br /> alldata = cur.fetchall()<br /><br /> if alldata[0][0] != 0:<br /> print "Warning: DB already exist for this article"<br /> continue;<br /><br /> #解析Html返回文章内容<br /> content = self.parseHtml(self.getUrlInfo(link), link)<br /> #存储图片文件到本地<br /> lister = ListUrls()<br /> lister.feed(content)<br /> self.saveimg(lister.imgs)<br /><br /> for img in lister.imgs:<br /> content = content.replace(img,Constants.IMG_LOCALDSTDIR +"/" + img.split("/")[-1].split(";")[0])<br /><br /> #封装成actrict类<br /> actrict.title = title<br /> actrict.link = link<br /> actrict.identifier = identifier<br /> actrict.description = description<br /> actrict.createdate = createdate<br /> actrict.creator = creator<br /> actrict.content = content <br /> #进行存本地数据库<br /> self.putDB(actrict)<br /> except :<br /> print "ERROR: PARSE_XMLRESS IS FAIL%s" % (link)<br /><br /> #解析XML取字符<br /> def getText(self, nodelist):<br /> rc = ""<br /> for node in nodelist:<br /> if node.nodeType == node.TEXT_NODE:<br /> rc = rc + node.data<br /> return rc<br /> #保存图片文件<br /> def saveimg(self, imgs):<br /> for img in imgs :<br /> try:<br /> if string.find(img, 'http') != 0:<br /> img = Constants.HTML_SITE + img <br /> DstDir = Constants.IMG_LOCALDSTDIR <br /> imgPath = DstDir + img.split("/")[-1].split(";")[0]<br /> print imgPath <br /> File = open(imgPath, "wb") <br /> #proxyConfig = 'http://%s:%s@%s' % (Constants.PROXY_USERNAME, Constants.PROXY_PASSWORD, Constants.PROXY_ADRESS)<br /> #inforMation = urllib.urlopen(img, proxies={'http':proxyConfig})<br /> inforMation = urllib.urlopen(img)<br /> jpg = inforMation.read()<br /> File.write(jpg)<br /> print("INFO: SAVE IMG:" + imgPath)<br /> except :<br /> print "ERROR: SAVA IMG IS FAIL:%s" % (img)<br /> finally:<br /> inforMation.close()<br /> File.close()<br /><br /> #存储DB<br /> def putDB(self, actrict):<br /> title = actrict.title<br /> link = actrict.link<br /> identifier = actrict.identifier<br /> description = actrict.description<br /> createdate = actrict.createdate<br /> creator = actrict.creator<br /> content = actrict.content<br /> print title<br /> try: <br /> conn = DBUTIL().getConnectionDB()<br /> cur = conn.cursor() <br /> SQL = "INSERT INTO ARTICLES(title,link,identifier,description,createdate,creator,content)VALUES\<br /> ('%s','%s','%s','%s','%s','%s','%s')" % (title, link, identifier, description, createdate, creator, content)<br /> cur.execute(SQL)<br /> conn.commit()<br /> print "INFO: SAVE ACTRICT IS SUCCESSFUL"<br /> except :<br /> print "ERROR: SAVE ACTRICT IS FAIL"<br /> finally: <br /> cur.close() <br /> conn.close()<br /><br /><br /><br />if __name__ == "__main__":<br /> webcrawler = webcrawlerhttpurl();<br /> xml_file = webcrawler.getUrlInfo(Constants.HTML_RESOURCE) <br /> webcrawler.parseRessXml(xml_file)<br /><br /><br />'''<br /> CREATE TABLE `ARTICLES` (<br /> `id` int(11) NOT NULL AUTO_INCREMENT,<br /> `title` varchar(500) DEFAULT NULL COMMENT '文章标题',<br /> `link` varchar(500) DEFAULT NULL COMMENT '文章完整链接',<br /> `description` varchar(5000) DEFAULT NULL COMMENT '描述信息',<br /> `creator` varchar(200) DEFAULT NULL COMMENT '作者',<br /> `createdate` varchar(200) DEFAULT NULL COMMENT '发布时间',<br /> `identifier` varchar(500) DEFAULT NULL COMMENT '关键字,用于区分文章是否已存在',<br /> `content` longtext COMMENT '内容',<br /> PRIMARY KEY (`id`)<br />) ENGINE=InnoDB AUTO_INCREMENT=4 DEFAULT CHARSET=utf8<br />'''<br /><br />

------------------------------

提供源码下载: 查看全部

写了个采集资源的小程序,原理:从上读取提供的RESS资源。然后按照资源中相关链接下载相应文章

RESS地址:

<br /> <br />- <br />- <br /> 未注册用户的 InfoQ 个性化 RSS Feed - 请注册后升级! <br /> http://www.infoq.com/cn/ <br /> 本 RSS Feed 是一个个性化定制的 Feed,对于您在 InfoQ.com 上的帐号(无论注册与否)都是唯一的。您可以从 InfoQ 网站左侧栏中的“您的社区”选项框内选择感兴趣的社区,此外您还可以通过关闭子话题和标签的方式过滤掉您不感兴趣的内容。您所做的选择将影响到本 RSS Feed 显示的新闻——新闻内容将和您在网站首页中央的新闻栏看见的内容保持一致。如果您的 RSS Feed 没有反映出这样的相关性,那么可能是因为您使用的 Feed 链接没有与您的 InfoQ 帐号相关联。为了确保您所使用的 Feed 的正确性,请先在 InfoQ 上注册,然后从网站左侧菜单中的“个性化 RSS”链接获取新的 RSS Feed URL。祝您使用愉快! <br />- <br />- <br /> <br /> <br /> <br /> <br /> <br /> <br /> <br /> <br /> <br /> <br /> <br /> <br /> <br /> <br /> <br /> <br /> <br /> <br />- <br /> PetaPoco:适用于.NET的微型ORM <br /> http://www.infoq.com/cn/news/2011/06/petapoco <br /> >PetaPoco是一款适用于.NET应用程序的对象关系映射器(ORM, Object Relational Mapper)。与那些功能完备的ORM(如NHibernate或Entity Framework)不同的是,PetaPoco更注重易用性和性能,而非丰富的功能。使用PetaPoco只需要引入一个C#文件,可以使用强类型的POCO,并支持<br />.........<br />

得到一个RESS的标准XML文档,然后解析XML得相关文章信息,再步入解析,最后下载图片,保存文章信息到MYSQL数据库中

下面是代码:

<br />#! /usr/bin/env python <br /># -*- coding: utf-8 -*- <br /><br />import urllib<br />import re,sys<br />import string<br />from xml.dom.minidom import parseString<br />from sgmllib import SGMLParser <br />import MySQLdb<br />reload(sys)<br />sys.setdefaultencoding('utf8')<br /><br /><br />class Constants():<br /> #站点<br /> HTML_SITE = "http://www.infoq.com";<br /> #聚体资源<br /> HTML_RESOURCE = HTML_SITE + "/cn/rss/rss.action?token=v4OEYqEXG7ltwOPp5IpH34Ky6WdtpXqz"; <br /> #数据库配置<br /> DB_HOST = "localhost" <br /> #数据库用户名<br /> DB_USER = "root"<br /> #数据库密码<br /> DB_PASSWORD = "root"<br /> #数据库<br /> DB_DATABASE = "test"<br /> #数据库连接编码集<br /> CHARSET = "utf8"<br /> #代理服务器<br /> PROXY_ADRESS = ""<br /> #代理用户名<br /> PROXY_USERNAME = ""<br /> #代理用户密码<br /> PROXY_PASSWORD = ""<br /> #图片本地保存路径<br /> IMG_LOCALDSTDIR = "E:/image/"<br /><br /><br /><br />class ListUrls(SGMLParser): <br /> def reset(self): <br /> self.imgs = [] <br /> SGMLParser.reset(self) <br /> def start_img(self, attrs): <br /> src = [v for k, v in attrs if k == 'src'] <br /> if src: <br /> self.imgs.extend(src)<br />#数据库工具类<br />class DBUTIL():<br /> def getConnectionDB(self):<br /> try:<br /> conn = MySQLdb.connect(host=Constants.DB_HOST, user=Constants.DB_USER, passwd=Constants.DB_PASSWORD, db=Constants.DB_DATABASE, charset=Constants.CHARSET)<br /> return conn<br /> except:<br /> print "EROOR: get ConnectionDB is FAIL"<br /><br />#文章对象用于从网站中爬取然后存储在DB中<br />class actrict():<br /> title = ''<br /> link = ''<br /> description = ''<br /> creator = ''<br /> createdate = ''<br /> identifier = ''<br /> content = ''<br /><br />class webcrawlerhttpurl(): <br /> #获取HTML内容 <br /> def getUrlInfo(self, weburl):<br /> try :<br /> #proxyConfig = 'http://%s:%s@%s' % (Constants.PROXY_USERNAME, Constants.PROXY_PASSWORD, Constants.PROXY_ADRESS)<br /> #inforMation = urllib.urlopen(weburl, proxies={'http':proxyConfig})<br /> inforMation = urllib.urlopen(weburl)<br /> #header = inforMation.info() <br /> #contentType = header.getheader('Content-Type') <br /> status = inforMation.getcode() <br /> if status == 200: <br /> html = inforMation.readlines() <br /> return html <br /> else:<br /> return 'ERROR: get web %s% is fail and status=%s' % (weburl, status);<br /> except:<br /> print 'ERROR: get web %s% is fail' % (weburl);<br /> finally:<br /> inforMation.close() <br /><br /> #解析HTML<br /> def parseHtml(self, html, link):<br /> try:<br /> #body是一个list,需要转成string<br /> document = ""<br /> for line in html:<br /> if line.split():<br /> document = document + line <br /> #title<br /> title = document[re.search("title>", document).end():] <br /> title = title[:re.search("title>", title).end() - 8]<br /><br /> #content<br /> content = document[re.search("box-content-5", document).end():]<br /> content = content[:re.search("bottom-corners", content).end()] <br /> content = document[re.search("", document).end():] <br /> content = content[:re.search("", content).end() - 33] <br /> content = content.replace("'", "\\'") <br /><br /> except:<br /> print 'ERROR:PARSEHTML IS FAIL %s' % (link) <br /> return content<br /> #解析RESS然后访问其中每个具体资源<br /> def parseRessXml(self, xml_file): <br /> #body是一个list,需要转成string<br /> document = ""<br /> for line in xml_file:<br /> document = document + line <br /> doc = parseString(document)<br /> pkgs = doc.getElementsByTagName("item") <br /> #遍历所有的资源地址<br /> i = 0;<br /> for pkg in pkgs:<br /> try:<br /> i = i + 1<br /> print '-------------------PARSE HTML (%s)-----------------' % (i)<br /> title = pkg.getElementsByTagName("title")<br /> title = self.getText(title[0].childNodes)<br /> link = pkg.getElementsByTagName("link")<br /> link = self.getText(link[0].childNodes)<br /> description = pkg.getElementsByTagName("description")<br /> description = self.getText(description[0].childNodes)<br /> creator = pkg.getElementsByTagName("dc:creator")<br /> creator = self.getText(creator[0].childNodes)<br /> createdate = pkg.getElementsByTagName("dc:date")<br /> createdate = self.getText(createdate[0].childNodes)<br /> identifier = pkg.getElementsByTagName("dc:identifier")<br /> identifier = self.getText(identifier[0].childNodes)<br /><br /> #判断文章是否已存在<br /> conn = DBUTIL().getConnectionDB()<br /> cur = conn.cursor() <br /> SQL = "SELECT COUNT(1) FROM ARTICLES WHERE identifier='%s'"%(identifier)<br /> cur.execute(SQL)<br /> alldata = cur.fetchall()<br /><br /> if alldata[0][0] != 0:<br /> print "Warning: DB already exist for this article"<br /> continue;<br /><br /> #解析Html返回文章内容<br /> content = self.parseHtml(self.getUrlInfo(link), link)<br /> #存储图片文件到本地<br /> lister = ListUrls()<br /> lister.feed(content)<br /> self.saveimg(lister.imgs)<br /><br /> for img in lister.imgs:<br /> content = content.replace(img,Constants.IMG_LOCALDSTDIR +"/" + img.split("/")[-1].split(";")[0])<br /><br /> #封装成actrict类<br /> actrict.title = title<br /> actrict.link = link<br /> actrict.identifier = identifier<br /> actrict.description = description<br /> actrict.createdate = createdate<br /> actrict.creator = creator<br /> actrict.content = content <br /> #进行存本地数据库<br /> self.putDB(actrict)<br /> except :<br /> print "ERROR: PARSE_XMLRESS IS FAIL%s" % (link)<br /><br /> #解析XML取字符<br /> def getText(self, nodelist):<br /> rc = ""<br /> for node in nodelist:<br /> if node.nodeType == node.TEXT_NODE:<br /> rc = rc + node.data<br /> return rc<br /> #保存图片文件<br /> def saveimg(self, imgs):<br /> for img in imgs :<br /> try:<br /> if string.find(img, 'http') != 0:<br /> img = Constants.HTML_SITE + img <br /> DstDir = Constants.IMG_LOCALDSTDIR <br /> imgPath = DstDir + img.split("/")[-1].split(";")[0]<br /> print imgPath <br /> File = open(imgPath, "wb") <br /> #proxyConfig = 'http://%s:%s@%s' % (Constants.PROXY_USERNAME, Constants.PROXY_PASSWORD, Constants.PROXY_ADRESS)<br /> #inforMation = urllib.urlopen(img, proxies={'http':proxyConfig})<br /> inforMation = urllib.urlopen(img)<br /> jpg = inforMation.read()<br /> File.write(jpg)<br /> print("INFO: SAVE IMG:" + imgPath)<br /> except :<br /> print "ERROR: SAVA IMG IS FAIL:%s" % (img)<br /> finally:<br /> inforMation.close()<br /> File.close()<br /><br /> #存储DB<br /> def putDB(self, actrict):<br /> title = actrict.title<br /> link = actrict.link<br /> identifier = actrict.identifier<br /> description = actrict.description<br /> createdate = actrict.createdate<br /> creator = actrict.creator<br /> content = actrict.content<br /> print title<br /> try: <br /> conn = DBUTIL().getConnectionDB()<br /> cur = conn.cursor() <br /> SQL = "INSERT INTO ARTICLES(title,link,identifier,description,createdate,creator,content)VALUES\<br /> ('%s','%s','%s','%s','%s','%s','%s')" % (title, link, identifier, description, createdate, creator, content)<br /> cur.execute(SQL)<br /> conn.commit()<br /> print "INFO: SAVE ACTRICT IS SUCCESSFUL"<br /> except :<br /> print "ERROR: SAVE ACTRICT IS FAIL"<br /> finally: <br /> cur.close() <br /> conn.close()<br /><br /><br /><br />if __name__ == "__main__":<br /> webcrawler = webcrawlerhttpurl();<br /> xml_file = webcrawler.getUrlInfo(Constants.HTML_RESOURCE) <br /> webcrawler.parseRessXml(xml_file)<br /><br /><br />'''<br /> CREATE TABLE `ARTICLES` (<br /> `id` int(11) NOT NULL AUTO_INCREMENT,<br /> `title` varchar(500) DEFAULT NULL COMMENT '文章标题',<br /> `link` varchar(500) DEFAULT NULL COMMENT '文章完整链接',<br /> `description` varchar(5000) DEFAULT NULL COMMENT '描述信息',<br /> `creator` varchar(200) DEFAULT NULL COMMENT '作者',<br /> `createdate` varchar(200) DEFAULT NULL COMMENT '发布时间',<br /> `identifier` varchar(500) DEFAULT NULL COMMENT '关键字,用于区分文章是否已存在',<br /> `content` longtext COMMENT '内容',<br /> PRIMARY KEY (`id`)<br />) ENGINE=InnoDB AUTO_INCREMENT=4 DEFAULT CHARSET=utf8<br />'''<br /><br />

------------------------------

提供源码下载:

(续)如何获取互联网知识以形成自己的知识库/资料库

采集交流 • 优采云 发表了文章 • 0 个评论 • 250 次浏览 • 2020-08-08 19:23

X

tagLyst最初旨在标记文档. 现在,您还可以在“剪贴板”中标记图片/文本,并将其另存为“数据库”中的文档. 特别适合提取网页内容的一部分并将其存储为“卡”.

从那时起,采集互联网知识的宝藏就更加方便了!

采集和管理文本: 以“ 知乎”为例

我们仍然以“ 知乎”为例. “芝湖”是一种高质量的矿山.

\ 1. 首先打开tagLyst并切换到“浮动窗口模式”.

\ 2. 在“ 知乎”上搜索您感兴趣的问题时,如果找到喜欢的内容,请使用传统的Ctrl + C复制.

\ 3. tagLyst浮动窗口可以自动显示我们刚刚复制的内容. 我们需要做的就是更改文件标题或为其添加标签,然后单击“存档”. 如果发现麻烦,也可以直接单击存档,然后在tagLyst界面中对其进行缓慢组织.

(默认保存文件类型为TXT,也可以选择Markdown格式)

以Unsplash为例,采集和管理图片

\ 1. 首先打开tagLyst并切换到“浮动窗口模式”.

\ 2. 如果您在Unsplash网页上看到自己喜欢的图片,请右键单击“复制图片”.

\ 3. tagLyst浮动窗口可以自动显示我们刚刚复制的图片. 就像采集文本一样,直接选择标题,标签或文件.

管理下载文件,以Office模板为例

许多网站都提供高质量的Office模板下载. 我们下载的文件可能会散布在整个桌面或下载目录中,但是我们不知道何时需要特定文件.

类似地,使用tagLyst对其进行组织

\ 1. 首先打开tagLyst并切换到“浮动窗口模式”.

\ 2. 假设该Office模板文件在桌面上,则将其下载到网页上.

\ 3. 将文件拖到“浮动窗口”,选择数据库,然后直接归档.

一个更具体的例子,以棒球知识库为例

我们的一个小朋友非常喜欢棒球. 我一直在Wiki上采集一些棒球明星和经典比赛. 他将使用tagLyst构建“棒球明星数据库”. 有关具体操作,请参见以下GIF动画:

最后

所有采集的知识都存储在tagLyst的每个“数据库”中,您可以在需要时基于标签进行搜索.

即使如此,您通常也可以在“卡片模式”中浏览结果并添加“标签尺寸”,以使存档的数据真正成为我们的专有知识.

此外,对于保存在“数据库”中的文本文件/ Word / PDF / XLSX,tagLyst还支持全文搜索,这使获取知识变得更加容易!

您如何使自己领先于“知识增长”?最好尽快开始使用“ Internet”并建立自己的专有知识库!

tagLyst官方网站地址 查看全部

X