免规则采集器列表算法

免规则采集器列表算法很差,赚不到钱

采集交流 • 优采云 发表了文章 • 0 个评论 • 212 次浏览 • 2021-05-18 22:01

免规则采集器列表算法很差,采集可以去百度之类的搜索引擎找别人已经收录的url,对采集器本身要求极高,1个外链覆盖率要求远远大于100个1级外链。其次采集也要分1:1和1:n个比例。这样的规则我本身并不会采集外链,我的外链采集需求是高质量,1个外链覆盖率对技术要求很高。

我个人觉得:比较难了我之前在一家公司是负责百度的采集,我们是按照k计费的,一个外链2刀。我们花了大概3、4k买了百度的产品,然后到现在百度仍然不重视对这方面的重视,当然你也可以说就算只需要k1个外链,按照采集2刀计算,也够卖的了。但是按照k计费,我感觉是限制了采集的人可以采集到的外链,降低了采集的成本。

虽然带来的流量很可观,可是这种采集是必须要经过人工筛选的,很少有一个外链能够覆盖全部链接的,也就是说你的外链总会漏掉些好的、有用的链接。

采集外链其实也可以换句话说就是2个链接加一个外链。2个外链加一个内链加一个好的关键词会在百度的首页上显示出来,而关键词就那么几个。

原来可以这样,我也打算有这个一个采集器插件用来发外链。

百度不重视,赚不到钱我看好多百度账号,绑定了账号来发外链我印象非常深刻。我自己也有。 查看全部

免规则采集器列表算法很差,赚不到钱

免规则采集器列表算法很差,采集可以去百度之类的搜索引擎找别人已经收录的url,对采集器本身要求极高,1个外链覆盖率要求远远大于100个1级外链。其次采集也要分1:1和1:n个比例。这样的规则我本身并不会采集外链,我的外链采集需求是高质量,1个外链覆盖率对技术要求很高。

我个人觉得:比较难了我之前在一家公司是负责百度的采集,我们是按照k计费的,一个外链2刀。我们花了大概3、4k买了百度的产品,然后到现在百度仍然不重视对这方面的重视,当然你也可以说就算只需要k1个外链,按照采集2刀计算,也够卖的了。但是按照k计费,我感觉是限制了采集的人可以采集到的外链,降低了采集的成本。

虽然带来的流量很可观,可是这种采集是必须要经过人工筛选的,很少有一个外链能够覆盖全部链接的,也就是说你的外链总会漏掉些好的、有用的链接。

采集外链其实也可以换句话说就是2个链接加一个外链。2个外链加一个内链加一个好的关键词会在百度的首页上显示出来,而关键词就那么几个。

原来可以这样,我也打算有这个一个采集器插件用来发外链。

百度不重视,赚不到钱我看好多百度账号,绑定了账号来发外链我印象非常深刻。我自己也有。

取消DEDE未登陆时出现的登陆提示自动登陆DEDE修改一处DEDE的代码

采集交流 • 优采云 发表了文章 • 0 个评论 • 152 次浏览 • 2021-05-18 07:31

此方法适用于所有DEDE模型和模块,所有发行模块仅需添加一个配置参数。

实现步骤如下:

取消DEDE未登录时出现的登录提示

自动登录DEDE

在DEDE程序管理员目录中将DEDE代码修改为config.php,默认路径为dede / config.php,代码如下:

//检验用户登录状态 $cuserLogin = new userLogin(); if($cuserLogin->getUserID()==-1) { header("location:login.php?gotopage=".urlencode($dedeNowurl)); exit(); }

此代码的功能是在未检测到用户的登录信息的情况下引导用户进入登录过程,并对其进行如下修改:

//检验用户登录状态 $cuserLogin = new userLogin(); if($cuserLogin->getUserID()==-1) { if($my_u != ''){ $res = $cuserLogin->checkUser($my_u, $my_p); if($res==1) $cuserLogin->keepUser(); } if($cuserLogin->getUserID()==-1) { header("location:login.php?gotopage=".urlencode($dedeNowurl)); exit(); } }

此代码的功能是在检测到用户未登录时尝试使用从页面传递的参数登录。如果登录成功,请保存用户信息并执行其他操作;否则,请执行以下操作。如果登录失败,请引导用户登录页面。

此代码已被修改。接下来,我们需要修改优采云 采集器的发布模块。

要修改发布模块,只需在发布模块中添加登录用户名和密码信息,如下图所示进行修改:

article_add.php?my_u =您的后台用户名&my_p =您的后台密码 查看全部

取消DEDE未登陆时出现的登陆提示自动登陆DEDE修改一处DEDE的代码

此方法适用于所有DEDE模型和模块,所有发行模块仅需添加一个配置参数。

实现步骤如下:

取消DEDE未登录时出现的登录提示

自动登录DEDE

在DEDE程序管理员目录中将DEDE代码修改为config.php,默认路径为dede / config.php,代码如下:

//检验用户登录状态 $cuserLogin = new userLogin(); if($cuserLogin->getUserID()==-1) { header("location:login.php?gotopage=".urlencode($dedeNowurl)); exit(); }

此代码的功能是在未检测到用户的登录信息的情况下引导用户进入登录过程,并对其进行如下修改:

//检验用户登录状态 $cuserLogin = new userLogin(); if($cuserLogin->getUserID()==-1) { if($my_u != ''){ $res = $cuserLogin->checkUser($my_u, $my_p); if($res==1) $cuserLogin->keepUser(); } if($cuserLogin->getUserID()==-1) { header("location:login.php?gotopage=".urlencode($dedeNowurl)); exit(); } }

此代码的功能是在检测到用户未登录时尝试使用从页面传递的参数登录。如果登录成功,请保存用户信息并执行其他操作;否则,请执行以下操作。如果登录失败,请引导用户登录页面。

此代码已被修改。接下来,我们需要修改优采云 采集器的发布模块。

要修改发布模块,只需在发布模块中添加登录用户名和密码信息,如下图所示进行修改:

article_add.php?my_u =您的后台用户名&my_p =您的后台密码

gb2312GetSiteUrl(站点地址)(规则编号)_光明网(组图)

采集交流 • 优采云 发表了文章 • 0 个评论 • 109 次浏览 • 2021-05-18 01:16

第1步:让我们复制原创规则作为模板。例如,我今天展示的采集网站是一个名为feiku的新颖网站,然后我将复制的模板规则的副本命名为dhabc。 xml这主要是为了易于记忆。步骤2:我们在采集器中运行规则管理工具,并在打开后将其加载。我们只是将其命名为dhabc。 xml XML文件步骤3:开始正式编写规则RULEID(规则编号)这个任意的GetSiteName(站点名称)在这里我们编写GetSiteCharset(站点代码)在这里我们打开以查找字符集=该数字是我们需要我们的站点代码找到的是gb2312 GetSiteUrl(站点地址)。不用说,编写NovelSearchUrl(站点搜索地址)。根据每个网站程序的差异获得此地址。但是,有一种通用方法。通过捕获数据包获取所需的内容。尽管它是通过捕获数据包获得的,但我们如何知道所获得的正是我们想要的?看我的手术。首先,我们运行数据包工具并选择IEXPLORE。如果只打开一个网站,即只打开要编写规则以确保该过程中只有一个IEXPLORE的网站,则EXE进程是最好的。在此处输入EXE,我们可以看到提交的地址是/ book / search。

Aspx,我们将获得的地址SearchKey =%C1%AB%BB%A8&SearchClass = 1&SeaButton组合起来。 x = 26&SeaButton。 y = 10,但对我们有用的是SearchKey =%C1%AB%BB%A8&SearchClass = 1此处获得的本节将用于NovelSearchData(搜索提交)中,此处将本节更改为我们想要的代码。替换本段%带有{SearchKey}的C1%AB%BB%A8,这意味着搜索提交的内容是完整的代码,即SearchKey = {SearchKey}&SearchClass = 1然后我们测试它是否正确。经过测试,我们获得的内容是正确的NovelListUrl(最新的站点列表地址),由于每个站点都不相同,因此我不再赘述。您需要自己查找FEIKU NovelList_GetNovelKey(从最新列表中获取小说编号。在此规则中,您可以同时获取书名。手动获取书名。如果要使用手动模式,则必须获取书名,否则将无法使用手动模式。)我们打开此地址可以查看源文件。编写此规则时,我们会找到要获取内容的地方。例如,我们打开地址。我看到想要获得的内容的第一本小说的名字叫李迪承德。我们在源文件中找到了用于编写规则的代码。其实不多。我写规则的原则是保存或保存。也就是说,代码越短越好,除非绝对必要,否则代码越短越好。href =“。

云莱格。净/图书/ 149539 /索引。 html“ target =” _ blank“>站点为怪物href =”。云来阁。净/图书/(\ d *)/索引。 html“ target =” _ blank“>(。+?)。这意味着该小说的名称已经过正确测试。如果仅单击小说,就很容易找到NovelUrl(小说信息页面的地址),例如,我们可以看到这本小说,让我们在中间更改编号并随意更改它。我们得到的错误标记是找不到该编号的书籍信息!10. NovelName(查看源代码以获取名称我们可以从固定模式开始,例如刚打开的站点。对于Mo的小说,我们看到他的固定小说名称格式为“ Site into a Devil”,然后我们找到“ Site into a Devil”源代码中的“。我们得到的内容是

“进入恶魔之地”

我们更改此段

“(。+?)”

以下NovelAuthor(获得小说作者)LagerSort(获得小说类别)SmallSort(获得小说类别)NovelIntro(获得小说简介)NovelKeyword(获得小说主角(关键字))NovelDegree(获得写作过程)NovelCover(获得小说)(小说)封面)我不会证明这些与上述获取小说名称的方法相同,因此称为通行证。有时由于格式不固定,此处不使用某些获得的内容,并且某些内容只能先使用。获取并使用过滤器功能过滤掉过滤器的用法。我会说1 1. NovelInfo_GetNovelPubKey(获取新颖的公共目录页面的地址),该地址的获取方法与上述相同。在这里我将不解释12 PubIndexUrl(公共目录页面)地址)让我解释一下它的用法。通常在知道采集目标站的动态地址时使用。如果您不知道对方的动态地址,请在此输入{NovelPubKey}。如果您知道该工作站的动态路径,例如小说的章节目录的动态地址,则PubIndexUrl的规则为{NovelKey} /Index.aspx 1 3. PubVolumeSplit(拆分子卷)。在编写的地方,需要注意拆分子卷的规则性,否则可能会对以下章节名称产生很大影响。在这里,我们获得了分割部分的代码。根据我的经验,找到第一个子卷和随后的子卷以检查它们的共同点。我们分析该目录。本章中的源代码表明它们有一个共同点。用这一段来说明

对权力的追求

\ s * \ s *表示与任何白色字符匹配的匹配项,包括空格,制表符,分页符等。也就是说,无论它们之间有多少空格,它们都可以用来表示14 PubVolumeName(获取卷名称)要获取准确的子卷名称,上述拆分部分的规则性必须正确。通常,拆分部分的子卷名称在块的顶部。我们解释说使用了分割部分

对权力的追求

如果您关注此段,您会发现它收录我们要在此步骤中获取的子卷名称。让我们更改代码

(。+?)

\ s *在我们的测试下,我们可以正常获取子体积,但是通常会在过滤规则中将其过滤掉。 PubChapterName(获取章节名称)让我们以一段来说明强大的驯服方法。对于这种时间,日期和更新字数,我们直接忽略它,因为这些不是我们想要的。有人问为什么我在这里没用。 ()在此附上,让我告诉您,我们得到的内容就是()中的内容。如果不是您想要的,但是在编写规则时必须使用它,我们可以稍微更改一下表达式。让我们更改以上段落并将其更改为表达式(。+?),以正常获取内容。你们觉得这个规则有点尴尬吗?这是因为中间有一个换行符。我没有更改代码。我们使用\ s *来表示换行符,我们修改后的代码是(。+?)现在更好了吗?经过测试,获取内容也是正常的。没有问题。 16. PubChapter_GetChapterKey(获取章节地址(章节编号))在此说明,其中的章节编号在下面的PubContentUrl(章节内容页面地址)中使用。通常用于了解目标站的动态地址。通常,当目标站未知时不使用它。因此,在这里我们需要获取章节地址分析以获取(。

+?)由于这里是获取章节地址的原因,为什么我们仍然使用章节名称?这主要是为了避免获得的章节名称和获得的章节地址不匹配。这就是说写下一章的数字实际上没有问题,只需对其稍作更改(。+?)。将其更改为此,让我们对其进行测试并查看,然后对其进行更改以获取该数字。仅在知道目标站的动态地址时才能获得该编号。最多使用17个。PubContentUrl(章节内容页面地址)上面获得的章节地址中有解释。这是要知道目标。这是如何使用它。 149539这是新颖的数字。在这里,我们使用{NovelKey}代替3790336。这是在PubChapter_GetChapterKey中获得的章节。对于编号,我们使用{ChapterKey}而不是{NovelKey} / {ChapterKey}的组合。 ASPX是我们动态的章节地址!!!请记住,前提是您知道另一方的动态地址。如果您不知道对方的动态地址,那么我们在PubContentUrl(章节内容页面地址)中写的是{ChapterKey}18。PubContentText(获取章节内容)这种获取方法与获取章节名称相同。这没有解释。现在我们解释一下过滤的用法。这很简单。过滤是删除不需要的过滤器。一个地方是介绍章节名称子卷名和所获得的新颖章节内容。但是,章节内容是替代功能。简介章节名称子卷名称暂时没有替换规则。例如,我们获得的子卷称为text(),但是我们在子卷中时,只想获取文本的两个单词,然后在此处使用过滤器。过滤器的格式是过滤后的内容|过滤器中每个过滤器内容的中间使用|分隔介绍章节名称。过滤器子卷的名称是相同的,例如,据说当我们获得作者的名字时,书的内容中就有额外的内容。作者因其href =“ / Author / WB / 149539。”而随风而散。

html“>有些(有些)没有,因此我们不需要使用本书的作者\ *(。+?)首先获取内容。根据规则,我们获取的内容为href =” /作者/ WB / 149539。 html“>随风而散,我们要保留在本段中。随风而散,让我们这样做,因为它是固定的,因此只需添加href =” / Author / WB / 149539。 html“>这是一个更改。让我们对其进行更改,并将其更改为常规格式href =” / Author / WB / \ d *。 html“>就是这样,我们添加过滤器href =” / Author / WB / \ d * \。 html“> |内容是这样的。现在让我们讨论章节内容的替换。章节内容替换规则每行替换一次,格式如下。需要替换的内容替换为结果

这意味着过滤

这意味着替换。例如,在此站中有单词“ Feiku”的图片。我们应该做什么?在这里,我们使用替换。

替换内容仅在章节内容中有用。这专用于章节内容。有人问为什么我采集某个电台的章节总是空的。原因可能是空白的章节。可能是目标站刚刚重新启动。网站您的采集 IP被阻止,等等。在这里,我想解释一下,空的章节是由图片章节引起的。 采集器的采集内容的操作步骤将首先检查采集的章节是否为图片章节。如果您的PubContentImages(从章节内容中提取图片)的规律性不正确,请检查您的采集文本内容PubContentText(获取章节内容)是否为常规匹配If PubContentImages(从章节内容中提取图片)PubContentText(获取章节内容)没有匹配的内容,那么我们上面所说的空白章节的原因就会出现。编写完规则后,让我们测试规则是否可以正常获得。内容测试表明,我们编写的规则通常可以获取所需的内容 查看全部

gb2312GetSiteUrl(站点地址)(规则编号)_光明网(组图)

第1步:让我们复制原创规则作为模板。例如,我今天展示的采集网站是一个名为feiku的新颖网站,然后我将复制的模板规则的副本命名为dhabc。 xml这主要是为了易于记忆。步骤2:我们在采集器中运行规则管理工具,并在打开后将其加载。我们只是将其命名为dhabc。 xml XML文件步骤3:开始正式编写规则RULEID(规则编号)这个任意的GetSiteName(站点名称)在这里我们编写GetSiteCharset(站点代码)在这里我们打开以查找字符集=该数字是我们需要我们的站点代码找到的是gb2312 GetSiteUrl(站点地址)。不用说,编写NovelSearchUrl(站点搜索地址)。根据每个网站程序的差异获得此地址。但是,有一种通用方法。通过捕获数据包获取所需的内容。尽管它是通过捕获数据包获得的,但我们如何知道所获得的正是我们想要的?看我的手术。首先,我们运行数据包工具并选择IEXPLORE。如果只打开一个网站,即只打开要编写规则以确保该过程中只有一个IEXPLORE的网站,则EXE进程是最好的。在此处输入EXE,我们可以看到提交的地址是/ book / search。

Aspx,我们将获得的地址SearchKey =%C1%AB%BB%A8&SearchClass = 1&SeaButton组合起来。 x = 26&SeaButton。 y = 10,但对我们有用的是SearchKey =%C1%AB%BB%A8&SearchClass = 1此处获得的本节将用于NovelSearchData(搜索提交)中,此处将本节更改为我们想要的代码。替换本段%带有{SearchKey}的C1%AB%BB%A8,这意味着搜索提交的内容是完整的代码,即SearchKey = {SearchKey}&SearchClass = 1然后我们测试它是否正确。经过测试,我们获得的内容是正确的NovelListUrl(最新的站点列表地址),由于每个站点都不相同,因此我不再赘述。您需要自己查找FEIKU NovelList_GetNovelKey(从最新列表中获取小说编号。在此规则中,您可以同时获取书名。手动获取书名。如果要使用手动模式,则必须获取书名,否则将无法使用手动模式。)我们打开此地址可以查看源文件。编写此规则时,我们会找到要获取内容的地方。例如,我们打开地址。我看到想要获得的内容的第一本小说的名字叫李迪承德。我们在源文件中找到了用于编写规则的代码。其实不多。我写规则的原则是保存或保存。也就是说,代码越短越好,除非绝对必要,否则代码越短越好。href =“。

云莱格。净/图书/ 149539 /索引。 html“ target =” _ blank“>站点为怪物href =”。云来阁。净/图书/(\ d *)/索引。 html“ target =” _ blank“>(。+?)。这意味着该小说的名称已经过正确测试。如果仅单击小说,就很容易找到NovelUrl(小说信息页面的地址),例如,我们可以看到这本小说,让我们在中间更改编号并随意更改它。我们得到的错误标记是找不到该编号的书籍信息!10. NovelName(查看源代码以获取名称我们可以从固定模式开始,例如刚打开的站点。对于Mo的小说,我们看到他的固定小说名称格式为“ Site into a Devil”,然后我们找到“ Site into a Devil”源代码中的“。我们得到的内容是

“进入恶魔之地”

我们更改此段

“(。+?)”

以下NovelAuthor(获得小说作者)LagerSort(获得小说类别)SmallSort(获得小说类别)NovelIntro(获得小说简介)NovelKeyword(获得小说主角(关键字))NovelDegree(获得写作过程)NovelCover(获得小说)(小说)封面)我不会证明这些与上述获取小说名称的方法相同,因此称为通行证。有时由于格式不固定,此处不使用某些获得的内容,并且某些内容只能先使用。获取并使用过滤器功能过滤掉过滤器的用法。我会说1 1. NovelInfo_GetNovelPubKey(获取新颖的公共目录页面的地址),该地址的获取方法与上述相同。在这里我将不解释12 PubIndexUrl(公共目录页面)地址)让我解释一下它的用法。通常在知道采集目标站的动态地址时使用。如果您不知道对方的动态地址,请在此输入{NovelPubKey}。如果您知道该工作站的动态路径,例如小说的章节目录的动态地址,则PubIndexUrl的规则为{NovelKey} /Index.aspx 1 3. PubVolumeSplit(拆分子卷)。在编写的地方,需要注意拆分子卷的规则性,否则可能会对以下章节名称产生很大影响。在这里,我们获得了分割部分的代码。根据我的经验,找到第一个子卷和随后的子卷以检查它们的共同点。我们分析该目录。本章中的源代码表明它们有一个共同点。用这一段来说明

对权力的追求

\ s * \ s *表示与任何白色字符匹配的匹配项,包括空格,制表符,分页符等。也就是说,无论它们之间有多少空格,它们都可以用来表示14 PubVolumeName(获取卷名称)要获取准确的子卷名称,上述拆分部分的规则性必须正确。通常,拆分部分的子卷名称在块的顶部。我们解释说使用了分割部分

对权力的追求

如果您关注此段,您会发现它收录我们要在此步骤中获取的子卷名称。让我们更改代码

(。+?)

\ s *在我们的测试下,我们可以正常获取子体积,但是通常会在过滤规则中将其过滤掉。 PubChapterName(获取章节名称)让我们以一段来说明强大的驯服方法。对于这种时间,日期和更新字数,我们直接忽略它,因为这些不是我们想要的。有人问为什么我在这里没用。 ()在此附上,让我告诉您,我们得到的内容就是()中的内容。如果不是您想要的,但是在编写规则时必须使用它,我们可以稍微更改一下表达式。让我们更改以上段落并将其更改为表达式(。+?),以正常获取内容。你们觉得这个规则有点尴尬吗?这是因为中间有一个换行符。我没有更改代码。我们使用\ s *来表示换行符,我们修改后的代码是(。+?)现在更好了吗?经过测试,获取内容也是正常的。没有问题。 16. PubChapter_GetChapterKey(获取章节地址(章节编号))在此说明,其中的章节编号在下面的PubContentUrl(章节内容页面地址)中使用。通常用于了解目标站的动态地址。通常,当目标站未知时不使用它。因此,在这里我们需要获取章节地址分析以获取(。

+?)由于这里是获取章节地址的原因,为什么我们仍然使用章节名称?这主要是为了避免获得的章节名称和获得的章节地址不匹配。这就是说写下一章的数字实际上没有问题,只需对其稍作更改(。+?)。将其更改为此,让我们对其进行测试并查看,然后对其进行更改以获取该数字。仅在知道目标站的动态地址时才能获得该编号。最多使用17个。PubContentUrl(章节内容页面地址)上面获得的章节地址中有解释。这是要知道目标。这是如何使用它。 149539这是新颖的数字。在这里,我们使用{NovelKey}代替3790336。这是在PubChapter_GetChapterKey中获得的章节。对于编号,我们使用{ChapterKey}而不是{NovelKey} / {ChapterKey}的组合。 ASPX是我们动态的章节地址!!!请记住,前提是您知道另一方的动态地址。如果您不知道对方的动态地址,那么我们在PubContentUrl(章节内容页面地址)中写的是{ChapterKey}18。PubContentText(获取章节内容)这种获取方法与获取章节名称相同。这没有解释。现在我们解释一下过滤的用法。这很简单。过滤是删除不需要的过滤器。一个地方是介绍章节名称子卷名和所获得的新颖章节内容。但是,章节内容是替代功能。简介章节名称子卷名称暂时没有替换规则。例如,我们获得的子卷称为text(),但是我们在子卷中时,只想获取文本的两个单词,然后在此处使用过滤器。过滤器的格式是过滤后的内容|过滤器中每个过滤器内容的中间使用|分隔介绍章节名称。过滤器子卷的名称是相同的,例如,据说当我们获得作者的名字时,书的内容中就有额外的内容。作者因其href =“ / Author / WB / 149539。”而随风而散。

html“>有些(有些)没有,因此我们不需要使用本书的作者\ *(。+?)首先获取内容。根据规则,我们获取的内容为href =” /作者/ WB / 149539。 html“>随风而散,我们要保留在本段中。随风而散,让我们这样做,因为它是固定的,因此只需添加href =” / Author / WB / 149539。 html“>这是一个更改。让我们对其进行更改,并将其更改为常规格式href =” / Author / WB / \ d *。 html“>就是这样,我们添加过滤器href =” / Author / WB / \ d * \。 html“> |内容是这样的。现在让我们讨论章节内容的替换。章节内容替换规则每行替换一次,格式如下。需要替换的内容替换为结果

这意味着过滤

这意味着替换。例如,在此站中有单词“ Feiku”的图片。我们应该做什么?在这里,我们使用替换。

替换内容仅在章节内容中有用。这专用于章节内容。有人问为什么我采集某个电台的章节总是空的。原因可能是空白的章节。可能是目标站刚刚重新启动。网站您的采集 IP被阻止,等等。在这里,我想解释一下,空的章节是由图片章节引起的。 采集器的采集内容的操作步骤将首先检查采集的章节是否为图片章节。如果您的PubContentImages(从章节内容中提取图片)的规律性不正确,请检查您的采集文本内容PubContentText(获取章节内容)是否为常规匹配If PubContentImages(从章节内容中提取图片)PubContentText(获取章节内容)没有匹配的内容,那么我们上面所说的空白章节的原因就会出现。编写完规则后,让我们测试规则是否可以正常获得。内容测试表明,我们编写的规则通常可以获取所需的内容

智能在程序合成研究中遇到的提取任务上的评估

采集交流 • 优采云 发表了文章 • 0 个评论 • 111 次浏览 • 2021-05-10 04:24

智能在程序合成研究中遇到的提取任务上的评估

报价

Raza,M.&Gulwani,S ..(201 7)。使用预测程序合成的自动数据提取。AAAI201 7.

一、摘要

近年来,人们对使用示例编程技术来帮助用户完成数据处理任务越来越感兴趣。该技术依靠用户定义的输入和输出实例规范来自动合成程序。但是,在各种各样的数据提取任务中,人类观察者仅需要观察输入数据本身即可轻松预测所需的提取结果。在程序综合研究中还没有探索这种预测智能,这也是我们在这项工作中要解决的问题。我们描述了一种预测性程序合成算法,该算法可以仅以输入示例为例,以提取DSL(域特定语言)的一般形式导出程序。我们在文本提取和网络提取这两个实际应用领域中描述了此类DSL和合成算法的具体示例,并介绍了我们的技术来评估一系列实践中遇到的提取任务。

二、简介

随着世界数据的不断增长,近年来,学术界和工业界对使用自动编程技术解决数据纠缠问题越来越感兴趣:数据科学家面临的挑战是如何处理来自不同领域的数据资料来源。各种格式的数据,并将这些原创数据转换为适合其分析工具的形式。数据预处理是一项耗时的活动(在某些情况下,多达80%的活动(Kandel等,2011)),并且通常需要具备编程技能才能编写强大的提取或转换脚本。

这也是自动生成此类程序的一个非常有利的地方-它不仅加快了数据排序过程的速度,而且还允许非熟练程序员的数据分析人员和知识工作者使用它。与数据处理中不透明的自动推理技术相比,用户对推断的转换了解甚少,并且自动程序合成是可重用的(一次性学习轻量级脚本,以后可以存储并应用于类似的数据集) ),以及透明性和可编辑性的优点:转换是受经典编程语言启发的程序,必要时可以手动进行编辑。

为了实现此目标,许多作品都通过示例(PBE)方法探索了各种编程方法。在PBE中,用户可以通过提供一些输入和输出示例来指定他们的预期任务,然后系统尝试自动生成符合给定示例的特定领域语言(DSL)程序。在该领域的显着商业成功是基于PBE技术的Microsoft Excel中的Flash Fill功能。

但是,PBE方法依赖于用户要执行的任务的明确意图规范,这通常需要用户正确理解示例以帮助系统推断正确的程序,并且还可能需要许多用户。任务类型花费大量的精力。在这项工作中,我们发现并解决了各种数据提取任务。该系统可以在没有明确的示例规范的情况下运行,并且仅基于输入数据的属性以纯预测性的方式生成提取脚本。因此,这可以视为仅从输入实例而不是输入和输出实例进行推断。我们首先在这里研究的两个特定应用领域中说明这种提取方案,然后再更详细地讨论预测方法及其好处。

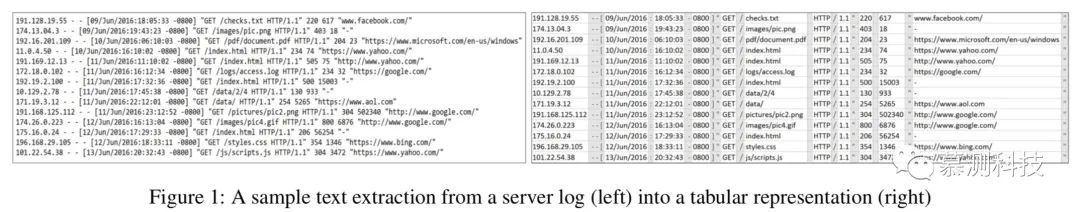

文本提取

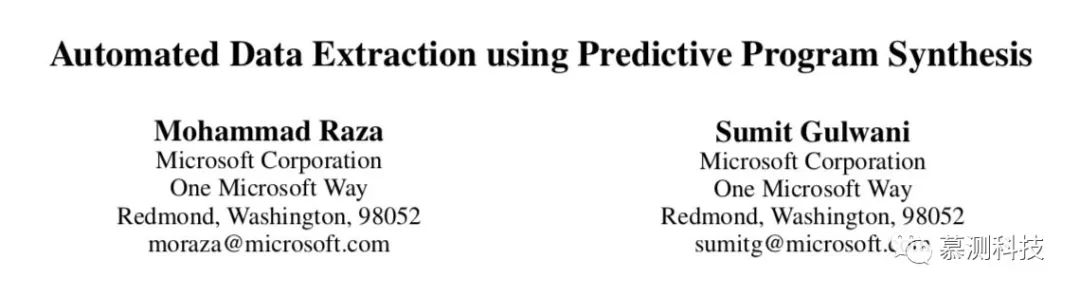

图1显示了一种文本提取方案,其中输入数据集(如上所示)收录来自Web服务器日志的条目。每行是一个文本字符串,其中收录客户端IP地址,日期和其他值,这些值由此日志格式唯一的各种分隔区域分隔。我们的目标是将这些值提取到单独的列中,如图底部表格所示,其中突出显示了代表单独区域的列。

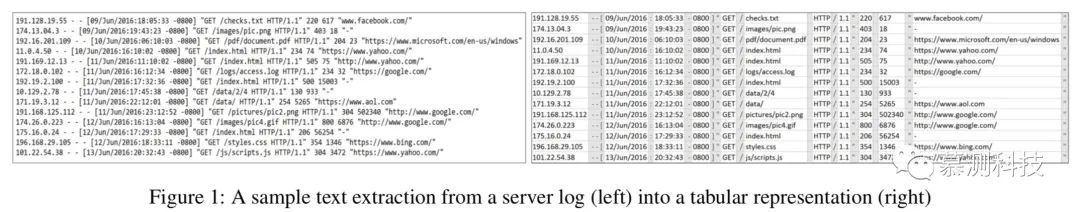

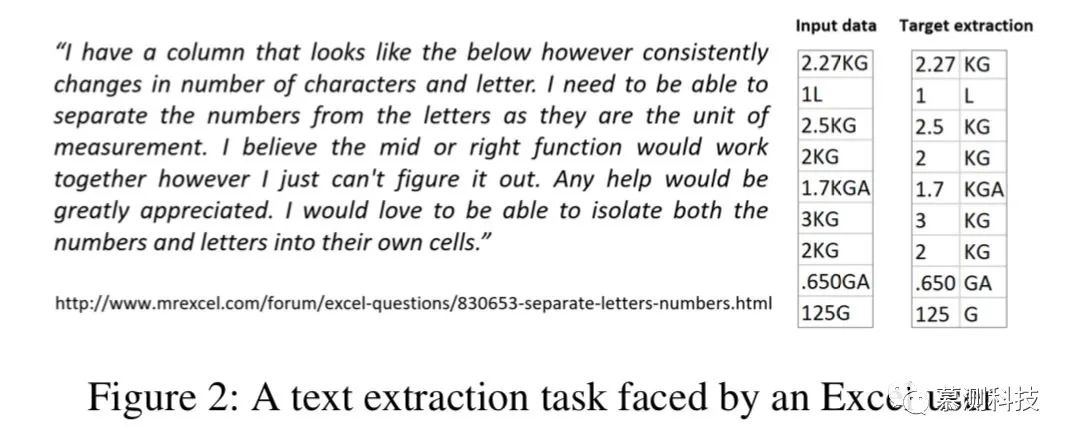

在诸如CSV之类的简单文本格式中,此提取任务相对简单,因为通常使用固定的单字符定界符来分隔数据值。但是通常,如图1所示,可以在同一数据集中使用任意数量的字符串定界符,并且某些地方甚至某些地方甚至可以使用特定的字符串作为定界符,而在其他地方则不使用。例如,在图1中,“ /”字符是分隔HTTP协议版本的分隔符,但不应在URL中用作分隔符。因此,不可能简单地将所有出现的特定字符串分开。实际上,在许多情况下,两个数据值之间实际上没有分隔符。例如,图2在Excel帮助论坛上显示了一个用户的提取任务,该用户正在尝试将具有很大变化的数据集中的值和度量单位分开。在这种情况下,显然没有定界字符,因此我们的目标实际上是找到零长度定界区域,该区域是字符串中的单点,由左侧数字和右侧字母的上下文定义。

网页提取

自动数据提取的另一个领域是从网页中提取表信息,尤其是在网页中没有显式可视化(逐列)表的情况下。例如,图3显示了提取Amazon产品搜索结果的任务。每个结果项都有许多字段,例如标题,日期,各种价格等。这些字段未按清晰的逐行列表排列。其中一些字段丢失。在网页的DOM(文档对象模型)树结构中,使用不同的格式属性代替简单的HTML表格标签来表示它们。而且某些字段(例如“新”和“二手”的价格)实际上在格式上是相同的,并且只能通过检查文本内容来区分。

因此,由于每个网站使用不同形式的信息表示,因此在每种情况下都需要特殊的提取脚本。尽管基于特定标签或视觉属性进行自动表检测的工作很多,但是大多数非视觉表的提取都是在用户提供的示例的帮助下进行的。

预测性程序综合

以上提取方案已通过各种PBE方法解决,这些方法要求用户通过特定的提取示例来说明其意图。但是,在所有这些情况下,人们都可以通过观察输入数据本身轻松地预测所需的提取,而无需告知要提取什么。在程序综合研究中尚未探索这种预测智能,这是我们在此工作中要解决的问题:从仅输入示例中自动学习和提取程序。与以前基于PBE的技术相比,我们在此提出的预测方法具有许多优势。

我们首先定义了用于执行数据提取的DSL的一般形式。以这种形式,程序被构造为具有不同数据字段的独立子例程的组合。我们使用为文本和Web提取字段设计的特定DSL来说明这一点。这些DSL基于经典语言,例如正则表达式和CSS(级联样式表)选择器,它们可以表达上述场景中描述的一系列转换。然后,我们描述了一种新颖的预测综合算法,用于针对给定的输入数据集推断提取DSL中的程序。这是一个与领域无关的算法。它通过生成语义上等效的程序以有效的自下而上的方式运行,并使用子程序之间的对应关系概念作为中心排序原则。我们描述了该算法的特定示例以及文本和网络域之间的排名关系,并描述了我们的技术对从日志文件,真实用户和网络获得的实际测试场景的评估。最后,我们讨论了结论和未来的工作。

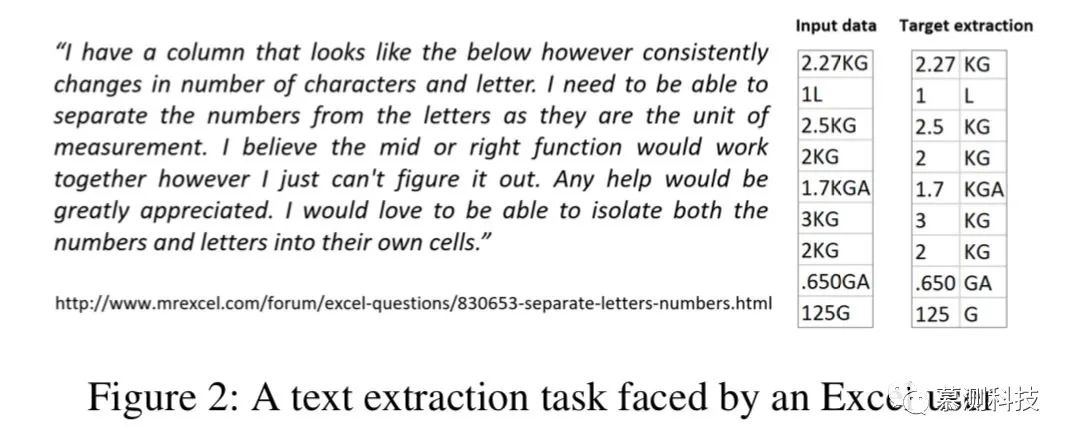

三、 ColumnSplit的评估评估

为了在文本域中进行评估,我们从产品团队,帮助论坛和组织中的真实用户那里采集了20个基准案例集,这些用户为我们提供了他们想要提取的数据集。其中许多数据集来自各种日志文件,例如Web服务器,但它们还包括其他基于文本的数据集。我们评估的目的是测量系统可以提取的最大字段数。

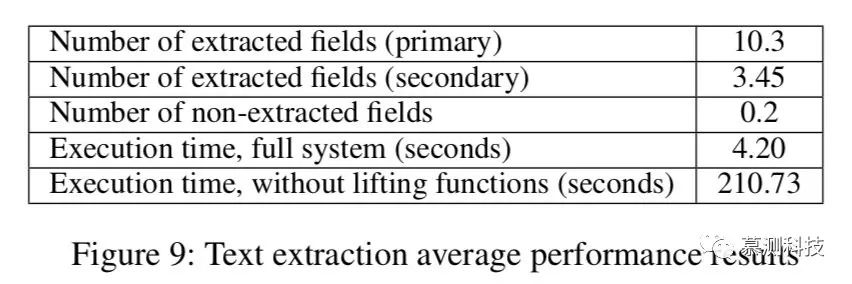

我们的系统在这些基准上的平均性能结果如图9所示。每个数据集的平均值为1 3. 95个字段,其中第一次尝试检测到1 0. 3个字段,[通过进一步拆分一些列来提取k30] 45个字段(在任何测试情况下,最多需要拆分三层),根本无法提取0. 2个字段。所有未提取的字段都在一个测试用例中,这是一项在不同输入上涉及不同数量字段的任务。对于可能遗漏的这种类型的字段,通常无法确定所需的字段对齐方式,因为存在不同的选择,因此可以通过用户的某个输出规范(例如示例)来最好地处理此类任务。每个任务的平均执行时间为4. 2秒,并在2秒内完成16个任务。可以观察到,在综合算法的每次迭代中,内存使用量大约增加了一倍,仍处于可容忍的范围内,因为该算法仅在给定的输入状态价格下保持程序的状态空间为语义等。

为了进行比较,我们还评估了我们的系统,而没有使用原创文本第3节中描述的特定于操作员的提升功能,并且观察到执行时间急剧增加,每个任务平均需要210秒。我们还研究了系统对提供给DSL Lt的标准数据类型标签的依赖性,并仅使用5个基本正则表达式标签(数字,小写字母,大写字母,字母数字和特殊字符)进行了重新实验。我们发现,在20个测试用例中,与其他案例中的大多数字段一样,提取了14个案例中的所有字段。

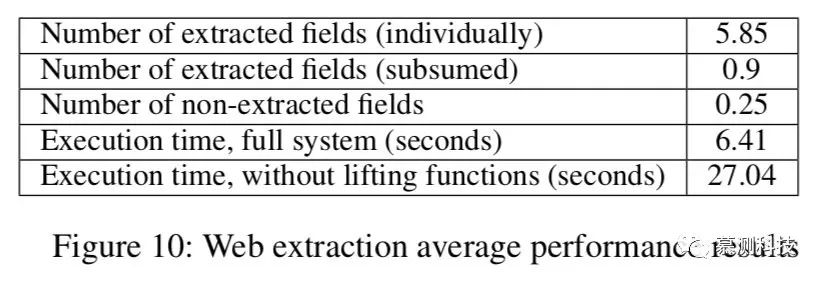

WebExtract的评估

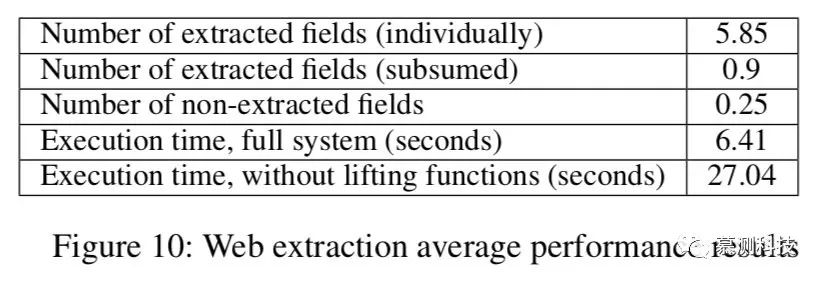

<p>在提取网页的情况下,我们对20个网页的集合进行了系统评估。这些网页中收录的表格数据未由显式HTML表格标记表示。评估结果如图10所示。我们的系统平均每页提取5. 85个字段。但是,页面上的某些(0. 9)字段未提取为单独的字段,而是“分类为”其他字段(例如,父节点收录两个具有不同字段的子节点,但被提取为字段)。 )。平均0.的25个字段完全没有提取,这仅发生在4个网页中。每个任务的平均执行时间为6. 41秒,尽管在2秒钟内完成了15个任务。提升了过滤器运算符的功能,执行时间增加到27秒,再次显示出明显的性能下降,以及为什么以前的自下而上的综合方法无法用于我们的预测环境(无论是文本区域还是网页区域)。 查看全部

智能在程序合成研究中遇到的提取任务上的评估

报价

Raza,M.&Gulwani,S ..(201 7)。使用预测程序合成的自动数据提取。AAAI201 7.

一、摘要

近年来,人们对使用示例编程技术来帮助用户完成数据处理任务越来越感兴趣。该技术依靠用户定义的输入和输出实例规范来自动合成程序。但是,在各种各样的数据提取任务中,人类观察者仅需要观察输入数据本身即可轻松预测所需的提取结果。在程序综合研究中还没有探索这种预测智能,这也是我们在这项工作中要解决的问题。我们描述了一种预测性程序合成算法,该算法可以仅以输入示例为例,以提取DSL(域特定语言)的一般形式导出程序。我们在文本提取和网络提取这两个实际应用领域中描述了此类DSL和合成算法的具体示例,并介绍了我们的技术来评估一系列实践中遇到的提取任务。

二、简介

随着世界数据的不断增长,近年来,学术界和工业界对使用自动编程技术解决数据纠缠问题越来越感兴趣:数据科学家面临的挑战是如何处理来自不同领域的数据资料来源。各种格式的数据,并将这些原创数据转换为适合其分析工具的形式。数据预处理是一项耗时的活动(在某些情况下,多达80%的活动(Kandel等,2011)),并且通常需要具备编程技能才能编写强大的提取或转换脚本。

这也是自动生成此类程序的一个非常有利的地方-它不仅加快了数据排序过程的速度,而且还允许非熟练程序员的数据分析人员和知识工作者使用它。与数据处理中不透明的自动推理技术相比,用户对推断的转换了解甚少,并且自动程序合成是可重用的(一次性学习轻量级脚本,以后可以存储并应用于类似的数据集) ),以及透明性和可编辑性的优点:转换是受经典编程语言启发的程序,必要时可以手动进行编辑。

为了实现此目标,许多作品都通过示例(PBE)方法探索了各种编程方法。在PBE中,用户可以通过提供一些输入和输出示例来指定他们的预期任务,然后系统尝试自动生成符合给定示例的特定领域语言(DSL)程序。在该领域的显着商业成功是基于PBE技术的Microsoft Excel中的Flash Fill功能。

但是,PBE方法依赖于用户要执行的任务的明确意图规范,这通常需要用户正确理解示例以帮助系统推断正确的程序,并且还可能需要许多用户。任务类型花费大量的精力。在这项工作中,我们发现并解决了各种数据提取任务。该系统可以在没有明确的示例规范的情况下运行,并且仅基于输入数据的属性以纯预测性的方式生成提取脚本。因此,这可以视为仅从输入实例而不是输入和输出实例进行推断。我们首先在这里研究的两个特定应用领域中说明这种提取方案,然后再更详细地讨论预测方法及其好处。

文本提取

图1显示了一种文本提取方案,其中输入数据集(如上所示)收录来自Web服务器日志的条目。每行是一个文本字符串,其中收录客户端IP地址,日期和其他值,这些值由此日志格式唯一的各种分隔区域分隔。我们的目标是将这些值提取到单独的列中,如图底部表格所示,其中突出显示了代表单独区域的列。

在诸如CSV之类的简单文本格式中,此提取任务相对简单,因为通常使用固定的单字符定界符来分隔数据值。但是通常,如图1所示,可以在同一数据集中使用任意数量的字符串定界符,并且某些地方甚至某些地方甚至可以使用特定的字符串作为定界符,而在其他地方则不使用。例如,在图1中,“ /”字符是分隔HTTP协议版本的分隔符,但不应在URL中用作分隔符。因此,不可能简单地将所有出现的特定字符串分开。实际上,在许多情况下,两个数据值之间实际上没有分隔符。例如,图2在Excel帮助论坛上显示了一个用户的提取任务,该用户正在尝试将具有很大变化的数据集中的值和度量单位分开。在这种情况下,显然没有定界字符,因此我们的目标实际上是找到零长度定界区域,该区域是字符串中的单点,由左侧数字和右侧字母的上下文定义。

网页提取

自动数据提取的另一个领域是从网页中提取表信息,尤其是在网页中没有显式可视化(逐列)表的情况下。例如,图3显示了提取Amazon产品搜索结果的任务。每个结果项都有许多字段,例如标题,日期,各种价格等。这些字段未按清晰的逐行列表排列。其中一些字段丢失。在网页的DOM(文档对象模型)树结构中,使用不同的格式属性代替简单的HTML表格标签来表示它们。而且某些字段(例如“新”和“二手”的价格)实际上在格式上是相同的,并且只能通过检查文本内容来区分。

因此,由于每个网站使用不同形式的信息表示,因此在每种情况下都需要特殊的提取脚本。尽管基于特定标签或视觉属性进行自动表检测的工作很多,但是大多数非视觉表的提取都是在用户提供的示例的帮助下进行的。

预测性程序综合

以上提取方案已通过各种PBE方法解决,这些方法要求用户通过特定的提取示例来说明其意图。但是,在所有这些情况下,人们都可以通过观察输入数据本身轻松地预测所需的提取,而无需告知要提取什么。在程序综合研究中尚未探索这种预测智能,这是我们在此工作中要解决的问题:从仅输入示例中自动学习和提取程序。与以前基于PBE的技术相比,我们在此提出的预测方法具有许多优势。

我们首先定义了用于执行数据提取的DSL的一般形式。以这种形式,程序被构造为具有不同数据字段的独立子例程的组合。我们使用为文本和Web提取字段设计的特定DSL来说明这一点。这些DSL基于经典语言,例如正则表达式和CSS(级联样式表)选择器,它们可以表达上述场景中描述的一系列转换。然后,我们描述了一种新颖的预测综合算法,用于针对给定的输入数据集推断提取DSL中的程序。这是一个与领域无关的算法。它通过生成语义上等效的程序以有效的自下而上的方式运行,并使用子程序之间的对应关系概念作为中心排序原则。我们描述了该算法的特定示例以及文本和网络域之间的排名关系,并描述了我们的技术对从日志文件,真实用户和网络获得的实际测试场景的评估。最后,我们讨论了结论和未来的工作。

三、 ColumnSplit的评估评估

为了在文本域中进行评估,我们从产品团队,帮助论坛和组织中的真实用户那里采集了20个基准案例集,这些用户为我们提供了他们想要提取的数据集。其中许多数据集来自各种日志文件,例如Web服务器,但它们还包括其他基于文本的数据集。我们评估的目的是测量系统可以提取的最大字段数。

我们的系统在这些基准上的平均性能结果如图9所示。每个数据集的平均值为1 3. 95个字段,其中第一次尝试检测到1 0. 3个字段,[通过进一步拆分一些列来提取k30] 45个字段(在任何测试情况下,最多需要拆分三层),根本无法提取0. 2个字段。所有未提取的字段都在一个测试用例中,这是一项在不同输入上涉及不同数量字段的任务。对于可能遗漏的这种类型的字段,通常无法确定所需的字段对齐方式,因为存在不同的选择,因此可以通过用户的某个输出规范(例如示例)来最好地处理此类任务。每个任务的平均执行时间为4. 2秒,并在2秒内完成16个任务。可以观察到,在综合算法的每次迭代中,内存使用量大约增加了一倍,仍处于可容忍的范围内,因为该算法仅在给定的输入状态价格下保持程序的状态空间为语义等。

为了进行比较,我们还评估了我们的系统,而没有使用原创文本第3节中描述的特定于操作员的提升功能,并且观察到执行时间急剧增加,每个任务平均需要210秒。我们还研究了系统对提供给DSL Lt的标准数据类型标签的依赖性,并仅使用5个基本正则表达式标签(数字,小写字母,大写字母,字母数字和特殊字符)进行了重新实验。我们发现,在20个测试用例中,与其他案例中的大多数字段一样,提取了14个案例中的所有字段。

WebExtract的评估

<p>在提取网页的情况下,我们对20个网页的集合进行了系统评估。这些网页中收录的表格数据未由显式HTML表格标记表示。评估结果如图10所示。我们的系统平均每页提取5. 85个字段。但是,页面上的某些(0. 9)字段未提取为单独的字段,而是“分类为”其他字段(例如,父节点收录两个具有不同字段的子节点,但被提取为字段)。 )。平均0.的25个字段完全没有提取,这仅发生在4个网页中。每个任务的平均执行时间为6. 41秒,尽管在2秒钟内完成了15个任务。提升了过滤器运算符的功能,执行时间增加到27秒,再次显示出明显的性能下降,以及为什么以前的自下而上的综合方法无法用于我们的预测环境(无论是文本区域还是网页区域)。

免规则采集器可用于什么百度贴吧,你知道吗?

采集交流 • 优采云 发表了文章 • 0 个评论 • 218 次浏览 • 2021-05-08 20:00

免规则采集器列表算法就是用来采集网页,比如百度,百度贴吧,百度知道,论坛等,步骤如下:1.首先打开电脑端浏览器,搜索“免规则采集器”;2.在跳转页面点击免规则采集器链接,进入页面后,如下图所示:3.填写完整信息后点击下一步按钮,如下图所示:4.点击提交按钮后,进入云采集页面,如下图所示:5.在提交结果页面中,用户可以对网页进行编辑,点击下一步按钮进行操作,如下图所示:6.采集结束后,点击结果预览按钮,查看采集成果,如下图所示:7.点击“完成”按钮,保存,如下图所示:8.在文本框中输入你想要采集的网址,如“百度</a>”,如下图所示:9.点击“开始免费试用”按钮,如下图所示:10.点击“付款”按钮,进行确认支付,如下图所示:11.恭喜你,你成功完成免规则采集器的使用!免规则采集器可用于什么百度搜索,百度贴吧,百度知道,百度百科,论坛等百度站点。

免规则采集器大致分为这么几种:

1、网页爬虫抓取的策略。

2、网页采集原理。

3、免规则采集器。你提的这个问题,从目前形式来看免规则采集器策略是用单独一个爬虫去采集百度首页所有的页面,通过技术手段让你爬虫爬取其他页面,爬取成功后再让你提交结果。建议你找些经验丰富的人进行集成配置,效果更好。 查看全部

免规则采集器可用于什么百度贴吧,你知道吗?

免规则采集器列表算法就是用来采集网页,比如百度,百度贴吧,百度知道,论坛等,步骤如下:1.首先打开电脑端浏览器,搜索“免规则采集器”;2.在跳转页面点击免规则采集器链接,进入页面后,如下图所示:3.填写完整信息后点击下一步按钮,如下图所示:4.点击提交按钮后,进入云采集页面,如下图所示:5.在提交结果页面中,用户可以对网页进行编辑,点击下一步按钮进行操作,如下图所示:6.采集结束后,点击结果预览按钮,查看采集成果,如下图所示:7.点击“完成”按钮,保存,如下图所示:8.在文本框中输入你想要采集的网址,如“百度</a>”,如下图所示:9.点击“开始免费试用”按钮,如下图所示:10.点击“付款”按钮,进行确认支付,如下图所示:11.恭喜你,你成功完成免规则采集器的使用!免规则采集器可用于什么百度搜索,百度贴吧,百度知道,百度百科,论坛等百度站点。

免规则采集器大致分为这么几种:

1、网页爬虫抓取的策略。

2、网页采集原理。

3、免规则采集器。你提的这个问题,从目前形式来看免规则采集器策略是用单独一个爬虫去采集百度首页所有的页面,通过技术手段让你爬虫爬取其他页面,爬取成功后再让你提交结果。建议你找些经验丰富的人进行集成配置,效果更好。

【知识点】免规则采集器列表算法保存多跳率保存

采集交流 • 优采云 发表了文章 • 0 个评论 • 178 次浏览 • 2021-05-07 23:05

免规则采集器列表算法保存多跳率保存每次转移到下一跳路径的概率我们采用中心匹配与边匹配相结合的方法来检测出转移树顶端到下一跳的路径。如果这些路径满足分析过程的任何一个条件则记录其边和节点集合的最大可能性。其中,中心匹配将匹配到转移树的中心节点和边。边匹配是匹配到转移树的边节点集合的边。中心匹配和边匹配使用类似于假设的边集和边查找算法。

例如,如果下一跳按照中心匹配保存的路径,那么转移树的顶端可能会有共1个节点,这样就有1-1=1条边,每个节点有自己的一条边。如果没有出现转移树顶端节点和边的路径,那么路径的最大可能性应该为(1/。

2)^2,也就是平均下来,的概率是2/3。直觉上来说,看上去每个节点都有可能有任意1个连通块,但是事实上路径的最大可能性一定是50%。

公式为:g[l]=l(c[i],i+2*l+

1),l[sel]=n(i,j)第二个公式,给定某个节点的下一步转移可能会来自下一个节点的概率记为。

二):s=ij-1一,查看下面的代码我们来使用uri来模拟转移轨迹://sourceurii/ofunctionrouter(dstdir,route){varuri=window.uri;varitemid=var(internet.ipv4.port);varicoadcycle=math.pow(2,math.abs(n));variq=-1;varidx=dstdir.length;for(varnindstdir){vari=nitemid+=var()itemid-=iq;route(idx,uri);}itemid=idx;}我们初始化各个转移节点的idx=n,转移id是一个随机数。

但是,这也能保证转移的顺序是固定的。那么,可以做什么呢?我们不希望转移节点c是所有a跳之前的转移节点的集合,也不希望转移节点b是所有b跳之前的转移节点的集合。我们希望转移节点c是转移到a跳或者a跳到c跳的转移节点的集合。我们希望他们是唯一的,而不是无重复的,也不希望c存在任何中心节点,所以在这个集合上的路径必须是唯一的。

之后,我们使用window.uri来给转移节点设置uri,我们使用的uri是在浏览器中查看得到的,如果我们在浏览器中直接使用网页的uri访问uri会报错。在浏览器中查看uri请参考博客:刘朝松:用uri访问uri的报错信息很不错的结果,下面我们来编码实现我们的代码://sourceurii/ovaruri=window.uri;varitemid=var(internet.ipv4.port);varicoadcycle=math.pow(2,math.abs(n。 查看全部

【知识点】免规则采集器列表算法保存多跳率保存

免规则采集器列表算法保存多跳率保存每次转移到下一跳路径的概率我们采用中心匹配与边匹配相结合的方法来检测出转移树顶端到下一跳的路径。如果这些路径满足分析过程的任何一个条件则记录其边和节点集合的最大可能性。其中,中心匹配将匹配到转移树的中心节点和边。边匹配是匹配到转移树的边节点集合的边。中心匹配和边匹配使用类似于假设的边集和边查找算法。

例如,如果下一跳按照中心匹配保存的路径,那么转移树的顶端可能会有共1个节点,这样就有1-1=1条边,每个节点有自己的一条边。如果没有出现转移树顶端节点和边的路径,那么路径的最大可能性应该为(1/。

2)^2,也就是平均下来,的概率是2/3。直觉上来说,看上去每个节点都有可能有任意1个连通块,但是事实上路径的最大可能性一定是50%。

公式为:g[l]=l(c[i],i+2*l+

1),l[sel]=n(i,j)第二个公式,给定某个节点的下一步转移可能会来自下一个节点的概率记为。

二):s=ij-1一,查看下面的代码我们来使用uri来模拟转移轨迹://sourceurii/ofunctionrouter(dstdir,route){varuri=window.uri;varitemid=var(internet.ipv4.port);varicoadcycle=math.pow(2,math.abs(n));variq=-1;varidx=dstdir.length;for(varnindstdir){vari=nitemid+=var()itemid-=iq;route(idx,uri);}itemid=idx;}我们初始化各个转移节点的idx=n,转移id是一个随机数。

但是,这也能保证转移的顺序是固定的。那么,可以做什么呢?我们不希望转移节点c是所有a跳之前的转移节点的集合,也不希望转移节点b是所有b跳之前的转移节点的集合。我们希望转移节点c是转移到a跳或者a跳到c跳的转移节点的集合。我们希望他们是唯一的,而不是无重复的,也不希望c存在任何中心节点,所以在这个集合上的路径必须是唯一的。

之后,我们使用window.uri来给转移节点设置uri,我们使用的uri是在浏览器中查看得到的,如果我们在浏览器中直接使用网页的uri访问uri会报错。在浏览器中查看uri请参考博客:刘朝松:用uri访问uri的报错信息很不错的结果,下面我们来编码实现我们的代码://sourceurii/ovaruri=window.uri;varitemid=var(internet.ipv4.port);varicoadcycle=math.pow(2,math.abs(n。

Octopus·云收集Web搜寻器软件有哪些免费的Web数据收集器?

采集交流 • 优采云 发表了文章 • 0 个评论 • 128 次浏览 • 2021-05-04 02:12

Octopus·云收集Web搜寻器软件有哪些免费的Web数据收集器?

Octopus·Cloud 采集 Web Searcher软件有哪些免费的Web数据采集器?当涉及到免费的Web数据采集器时,我相信import.io适合每个人。据了解,它已经引起了国内人们的关注,获得并获得了超过1000万美元的A轮融资。 Import.io两者之间的区别在于,用户只需单击网站几次即可获取数据,然后您可以根据您的操作计算要获取的数据,然后使用这些Real创建数据。 -time连接,那么您只需要选择所需的导出形式,就可以获取指定的内容并实时更新数据。听起来真的很棒,就像产品名称“ magic”一样。有兴趣的朋友可以体验一下,但是您应该注意导入。.io更适合某些列表数据,例如微博和商店页面。这些类型通常不合适,因为它获取的字段不是全部字段。它基于特殊的选择性计算,因此用户需要根据需要进行选择和使用。然后,您一定想过中国最经典的网络爬网工具。开发速度最快,用户最多的是章鱼采集器。与Import.io不同,优采云采集器更加注重准确性。它需要获取用户明确的指令(即采集规则),然后执行操作。因此,可以应用更多类型的网页,甚至可以应用整个网络。

Octopus·Cloud 采集 Web爬虫软件大数据技术已经开发了很多年,然后从一种很酷的新技术转变为企业在生产和运营中实际部署的服务。其中,data 采集产品已经迎来了广阔的市场前景,无论市场上有很多很多不同的技术和不同的采集软件。今天,我们将比较十个主流采集软件网页采集器的优缺点。帮助您选择最合适的采集器,并体验数据搜索的乐趣。什么是国内网络数据采集器?机车是采集行业的资深人士。机车是一种Internet数据捕获,处理,分析和挖掘软件,可以捕获网页上分散的数据信息并进行一系列分析。在处理期间,可以准确地挖掘所需的数据。它的用户定位主要是针对具有一定代码基础的人员,适用于对退伍军人进行编程。采集功能非常完美,不仅限于网页和内容。可以下载任何文件格式。它具有智能的多身份识别系统和可选的身份验证方法以保护安全性。它支持PHP和C#插件扩展,以方便数据的修改和处理。很难获得伪原创的基本技能,并且对于没有编程基础的用户也很困难。章鱼云采集Web抓取程序软件结论:该机车适合编程专家使用,规则较为复杂,软件定位更加准确。 2. Octopus是一种无需编程的可视网页采集软件,可以快速从不同的网站中提取标准化数据,以帮助用户实现自动数据采集,编辑和标准化,并降低工作成本。

云采集是其主要功能。与其他采集软件相比,云采集可以更加准确,高效和。直观的操作,无需编写代码,采集规则,适合使用零基础编程的用户。即将推出[k25版本0非常智能,具有内置的智能算法和已建立的采集规则。用户可以设置相应的参数来实现网站和网站的自动采集应用。云采集是其主要功能,支持关机采集,并实现自动定时采集,支持多IP动态分配和验证代码破解,避免IP阻塞来采集数据列表,支持多种导出方法和导入网站适用于小白的采集软件用户试用一下,云功能是强大的,当然高级爬虫还可以开发其高级功能。 3.采集章鱼·云采集Web爬网程序软件一种简单易用的网页信息爬网程序软件,可以爬网网页文本,图表,超链接和其他网页元素。您还可以使用简单的Visual流程来采集它,从而为有数据采集需求的任何人提供服务。视觉过程操作与章鱼不同。采集客户的过程着重于定义数据和爬网路径。章鱼的统治程序非常清晰。用户确定每种软件这两个步骤都支持在索引图中进行爬网。暂停中显示的数据,也可以在手机网站上获取。成员之间可以互相帮助,以提高采集效率。同时,存在可以应用的模板资源。它功能强大,需要更多后续付款。

4. God Archer Cloud Crawler是基于God Archer分布式云采集器框架的新型云智能采集器/采集器,可以帮助用户快速获取大量标准化的Web数据。直接访问代理IP,避免IP阻塞,自动登录验证码,网站自动完成验证码输入网页采集器,并可以生成图标。采集的结果以表格形式显示。用户IP可以隐藏。结论:Archer与爬虫系统框架相似,是一个特定的集合,它还需要用户编写爬虫并需要代码库。 5. Madman Collector的一套网站内容采集软件,支持从各个论坛,网站和博客文章内容抓取中采集帖子和回复,要点共有三类:论坛采集器,cms采集器和博客采集器。它支持批量替换和过滤文章内容中的文本和链接。您可以同时批量发布到网站或论坛的多个部分。完成采集或发布任务后,它具有自动关机功能。整个网络的数据采集不是通用的。什么是免费的国外Web数据采集器1. Import.io Import.io是基于Web的Web数据采集平台,用户无需编写代码并单击即可生成提取器。与大多数国内采集软件相比,Import.io Octopus·Cloud采集Web爬虫软件更加智能,可以匹配并生成相似元素的列表,并且用户正在输入网站您也可以单击一下采集数据。

提供云服务,自动分配云节点并提供SaaS平台来存储数据,提供API导出接口,可以导出Google Sheets,Excel,Tableau等格式。结论版本:Import.io是智能开发的,易于采集,但是在处理某些复杂的网页结构方面较弱。 2. Octoparse Octoparse是功能齐全的Internet采集工具,具有许多内置的高效工具。用户无需编写代码数据就可以从复杂的网页结构中采集结构。采集页面设计简单友好,完全可视化,适合新手用户。提供cloud 采集服务,其速度可以达到cloud 采集广告拦截功能的4-10倍,通过减少加载时间来提高采集效率,提供Xpath设置,准确定位Web数据元素,支持导出多种数据格式,例如CSV,Excel,XML等。Clawfish Cloud 采集 Web Crawler软件具有多个版本。它分为免费版和付费版。两种付费版本均提供云服务。结论:Octoparse功能齐全,价格合理,可以应用于复杂的Web结构。在Facebook,Twitter和其他平台上,您可以选择使用Octoparse。

3. Visual Web Ripper Visual Web Ripper是支持各种功能的自动Web抓取工具。它适用于某些高级和困难的网页结构,并且用户需要具有较强的编程技能。它可以提取多种数据格式(列表页),提供IP代理以避免IP阻塞。支持多种数据导出格式。输出格式也可以通过编程进行定制。内置的调试器可以帮助用户自定义采集过程和输出格式。结论:Visual Web Ripper具有强大的功能和强大的自定义采集功能,适合具有丰富编程经验的用户。它不提供云采集服务,这可能会限制采集效率。 4. Content Grabber Octopus·Cloud 采集 Web爬网程序软件Content Grabber是功能最强大的Web爬网工具之一一.,它更适合具有高级编程技能的人,并提供许多强大的脚本编辑和调试界面。允许用户在不使用内置工具的情况下编写正则表达式。内置的调试器可以帮助用户调试代码并与某些软件开发平台连接,以供用户编辑搜索器脚本,提供API导出接口并支持自定义编程接口。结论:Content Grabber网页具有很强的适用性和强大的功能,不能完全为用户提供基本功能,不适合具有高级编程技能的人。

5. Mozenda Mozenda是基于云的数据采集软件,可为用户提供许多实用功能,包括数据云存储。它可以提取各种数据格式,但是很难处理不规则的数据结构(例如List和table)。内置的正则表达式工具要求用户编写对多种数据导出格式的支持,但不提供自定义界面。 Octopus Cloud 采集 Web爬虫软件结论:Mozenda提供数据云存储,但是难以处理复杂的网页结构,软件操作界面跳跃,用户体验不够友好,适合具有基本爬虫经验的人。上面的爬虫软件已经能够满足用户的需求采集。其中一些工具(例如Octopus,机车,Octoparse和Content Grabber)提供了许多高级功能来帮助用户使用内置的Regex,XPath工具和代理服务器。在复杂的网页中获取准确的数据。不建议没有基础编程的用户选择需要自定义编程的工具,例如机车和Content Grabber。当然,这完全取决于个人需求,毕竟什么才是最适合您的!相关采集教程:新浪微博数据采集:快乐布克小说采集:阿里巴巴企业名录采集教程:章鱼·云采集 Web爬虫软件高德地图数据采集方法爆炸文本采集方法百度相关搜索关键词 采集方法采集和采集携程旅行路线信息章鱼-由90万用户选择的Web数据采集器。

1.操作简单,任何人都可以使用:没有技术背景,您可以采集。完全可视化该过程,单击鼠标即可完成操作,您可以在2分钟内快速上手。 2.强大,可以使用任何网站:单击,登录,翻页,身份验证代码,瀑布流,Ajax脚本以异步方式加载数据,并且可以通过简单的设置来采集网页。 3.也可以执行云采集和关闭。配置采集任务后,可以将其关闭,并可以在云中执行该任务。庞大的云采集集群可以不间断地运行24 * 7,而无需担心IP阻塞和网络中断。 Octopus·Cloud 采集 Web爬虫软件4.具有免费+增值服务,您可以根据需要进行选择。免费版具有所有功能,可以满足用户的基本采集需求。同时,已经建立了一些增值服务(例如私有云)来满足高端付费企业用户的需求。 查看全部

Octopus·云收集Web搜寻器软件有哪些免费的Web数据收集器?

Octopus·Cloud 采集 Web Searcher软件有哪些免费的Web数据采集器?当涉及到免费的Web数据采集器时,我相信import.io适合每个人。据了解,它已经引起了国内人们的关注,获得并获得了超过1000万美元的A轮融资。 Import.io两者之间的区别在于,用户只需单击网站几次即可获取数据,然后您可以根据您的操作计算要获取的数据,然后使用这些Real创建数据。 -time连接,那么您只需要选择所需的导出形式,就可以获取指定的内容并实时更新数据。听起来真的很棒,就像产品名称“ magic”一样。有兴趣的朋友可以体验一下,但是您应该注意导入。.io更适合某些列表数据,例如微博和商店页面。这些类型通常不合适,因为它获取的字段不是全部字段。它基于特殊的选择性计算,因此用户需要根据需要进行选择和使用。然后,您一定想过中国最经典的网络爬网工具。开发速度最快,用户最多的是章鱼采集器。与Import.io不同,优采云采集器更加注重准确性。它需要获取用户明确的指令(即采集规则),然后执行操作。因此,可以应用更多类型的网页,甚至可以应用整个网络。

Octopus·Cloud 采集 Web爬虫软件大数据技术已经开发了很多年,然后从一种很酷的新技术转变为企业在生产和运营中实际部署的服务。其中,data 采集产品已经迎来了广阔的市场前景,无论市场上有很多很多不同的技术和不同的采集软件。今天,我们将比较十个主流采集软件网页采集器的优缺点。帮助您选择最合适的采集器,并体验数据搜索的乐趣。什么是国内网络数据采集器?机车是采集行业的资深人士。机车是一种Internet数据捕获,处理,分析和挖掘软件,可以捕获网页上分散的数据信息并进行一系列分析。在处理期间,可以准确地挖掘所需的数据。它的用户定位主要是针对具有一定代码基础的人员,适用于对退伍军人进行编程。采集功能非常完美,不仅限于网页和内容。可以下载任何文件格式。它具有智能的多身份识别系统和可选的身份验证方法以保护安全性。它支持PHP和C#插件扩展,以方便数据的修改和处理。很难获得伪原创的基本技能,并且对于没有编程基础的用户也很困难。章鱼云采集Web抓取程序软件结论:该机车适合编程专家使用,规则较为复杂,软件定位更加准确。 2. Octopus是一种无需编程的可视网页采集软件,可以快速从不同的网站中提取标准化数据,以帮助用户实现自动数据采集,编辑和标准化,并降低工作成本。

云采集是其主要功能。与其他采集软件相比,云采集可以更加准确,高效和。直观的操作,无需编写代码,采集规则,适合使用零基础编程的用户。即将推出[k25版本0非常智能,具有内置的智能算法和已建立的采集规则。用户可以设置相应的参数来实现网站和网站的自动采集应用。云采集是其主要功能,支持关机采集,并实现自动定时采集,支持多IP动态分配和验证代码破解,避免IP阻塞来采集数据列表,支持多种导出方法和导入网站适用于小白的采集软件用户试用一下,云功能是强大的,当然高级爬虫还可以开发其高级功能。 3.采集章鱼·云采集Web爬网程序软件一种简单易用的网页信息爬网程序软件,可以爬网网页文本,图表,超链接和其他网页元素。您还可以使用简单的Visual流程来采集它,从而为有数据采集需求的任何人提供服务。视觉过程操作与章鱼不同。采集客户的过程着重于定义数据和爬网路径。章鱼的统治程序非常清晰。用户确定每种软件这两个步骤都支持在索引图中进行爬网。暂停中显示的数据,也可以在手机网站上获取。成员之间可以互相帮助,以提高采集效率。同时,存在可以应用的模板资源。它功能强大,需要更多后续付款。

4. God Archer Cloud Crawler是基于God Archer分布式云采集器框架的新型云智能采集器/采集器,可以帮助用户快速获取大量标准化的Web数据。直接访问代理IP,避免IP阻塞,自动登录验证码,网站自动完成验证码输入网页采集器,并可以生成图标。采集的结果以表格形式显示。用户IP可以隐藏。结论:Archer与爬虫系统框架相似,是一个特定的集合,它还需要用户编写爬虫并需要代码库。 5. Madman Collector的一套网站内容采集软件,支持从各个论坛,网站和博客文章内容抓取中采集帖子和回复,要点共有三类:论坛采集器,cms采集器和博客采集器。它支持批量替换和过滤文章内容中的文本和链接。您可以同时批量发布到网站或论坛的多个部分。完成采集或发布任务后,它具有自动关机功能。整个网络的数据采集不是通用的。什么是免费的国外Web数据采集器1. Import.io Import.io是基于Web的Web数据采集平台,用户无需编写代码并单击即可生成提取器。与大多数国内采集软件相比,Import.io Octopus·Cloud采集Web爬虫软件更加智能,可以匹配并生成相似元素的列表,并且用户正在输入网站您也可以单击一下采集数据。

提供云服务,自动分配云节点并提供SaaS平台来存储数据,提供API导出接口,可以导出Google Sheets,Excel,Tableau等格式。结论版本:Import.io是智能开发的,易于采集,但是在处理某些复杂的网页结构方面较弱。 2. Octoparse Octoparse是功能齐全的Internet采集工具,具有许多内置的高效工具。用户无需编写代码数据就可以从复杂的网页结构中采集结构。采集页面设计简单友好,完全可视化,适合新手用户。提供cloud 采集服务,其速度可以达到cloud 采集广告拦截功能的4-10倍,通过减少加载时间来提高采集效率,提供Xpath设置,准确定位Web数据元素,支持导出多种数据格式,例如CSV,Excel,XML等。Clawfish Cloud 采集 Web Crawler软件具有多个版本。它分为免费版和付费版。两种付费版本均提供云服务。结论:Octoparse功能齐全,价格合理,可以应用于复杂的Web结构。在Facebook,Twitter和其他平台上,您可以选择使用Octoparse。

3. Visual Web Ripper Visual Web Ripper是支持各种功能的自动Web抓取工具。它适用于某些高级和困难的网页结构,并且用户需要具有较强的编程技能。它可以提取多种数据格式(列表页),提供IP代理以避免IP阻塞。支持多种数据导出格式。输出格式也可以通过编程进行定制。内置的调试器可以帮助用户自定义采集过程和输出格式。结论:Visual Web Ripper具有强大的功能和强大的自定义采集功能,适合具有丰富编程经验的用户。它不提供云采集服务,这可能会限制采集效率。 4. Content Grabber Octopus·Cloud 采集 Web爬网程序软件Content Grabber是功能最强大的Web爬网工具之一一.,它更适合具有高级编程技能的人,并提供许多强大的脚本编辑和调试界面。允许用户在不使用内置工具的情况下编写正则表达式。内置的调试器可以帮助用户调试代码并与某些软件开发平台连接,以供用户编辑搜索器脚本,提供API导出接口并支持自定义编程接口。结论:Content Grabber网页具有很强的适用性和强大的功能,不能完全为用户提供基本功能,不适合具有高级编程技能的人。

5. Mozenda Mozenda是基于云的数据采集软件,可为用户提供许多实用功能,包括数据云存储。它可以提取各种数据格式,但是很难处理不规则的数据结构(例如List和table)。内置的正则表达式工具要求用户编写对多种数据导出格式的支持,但不提供自定义界面。 Octopus Cloud 采集 Web爬虫软件结论:Mozenda提供数据云存储,但是难以处理复杂的网页结构,软件操作界面跳跃,用户体验不够友好,适合具有基本爬虫经验的人。上面的爬虫软件已经能够满足用户的需求采集。其中一些工具(例如Octopus,机车,Octoparse和Content Grabber)提供了许多高级功能来帮助用户使用内置的Regex,XPath工具和代理服务器。在复杂的网页中获取准确的数据。不建议没有基础编程的用户选择需要自定义编程的工具,例如机车和Content Grabber。当然,这完全取决于个人需求,毕竟什么才是最适合您的!相关采集教程:新浪微博数据采集:快乐布克小说采集:阿里巴巴企业名录采集教程:章鱼·云采集 Web爬虫软件高德地图数据采集方法爆炸文本采集方法百度相关搜索关键词 采集方法采集和采集携程旅行路线信息章鱼-由90万用户选择的Web数据采集器。

1.操作简单,任何人都可以使用:没有技术背景,您可以采集。完全可视化该过程,单击鼠标即可完成操作,您可以在2分钟内快速上手。 2.强大,可以使用任何网站:单击,登录,翻页,身份验证代码,瀑布流,Ajax脚本以异步方式加载数据,并且可以通过简单的设置来采集网页。 3.也可以执行云采集和关闭。配置采集任务后,可以将其关闭,并可以在云中执行该任务。庞大的云采集集群可以不间断地运行24 * 7,而无需担心IP阻塞和网络中断。 Octopus·Cloud 采集 Web爬虫软件4.具有免费+增值服务,您可以根据需要进行选择。免费版具有所有功能,可以满足用户的基本采集需求。同时,已经建立了一些增值服务(例如私有云)来满足高端付费企业用户的需求。

7款非常好用的办公软件,可以极大提高办公效率

采集交流 • 优采云 发表了文章 • 0 个评论 • 136 次浏览 • 2021-05-03 19:06

与您共享7个非常有用的办公软件,可以大大提高办公效率,每个软件都可以称为精品店,如果您愿意的话,请记住喜欢并给予支持〜

1、清单

Listary是一款功能非常强大的文件浏览,搜索增强,对话框增强软件。第一个功能是快速打开文件和应用程序。您可以在任何界面上双击Ctrl来快速打开目标,而不会最小化当前窗口。搜索结果出现后,默认情况下将首先显示该应用程序,您可以按空格键仅显示文件。

第二个功能是文件浏览器的增强。在资源管理器界面中,您不需要任何快捷键,只需直接按文件名,“列表”搜索框就会自动打开以自动检索文件。

Listary的第三个功能是增强了各种打开/保存对话框。在任何打开/保存/下载对话框界面的底部,将自动吸附Listary的搜索框,并且可以通过直接输入名称来快速定位目标文件夹。

这是快捷键。如果目标文件夹已打开,请按快捷键Ctrl + G在对话框中快速打开该文件夹,方便快捷。

2、更快

Quicker是一种可以提高计算机使用效率的软件。它允许Windows用户以最合适的方式和最快的软件工具触发所需的操作。它是一个基于场景的工具箱,也是一个用于创建和共享新工具平台的工具。

单击鼠标中键(可以设置)以弹出,位置跟随鼠标,并且可以通过移动一小段距离来触发动作。 28个可视化的操作按钮,建立操作快捷方式,快速启动软件并执行操作。

Quicker支持自定义动作,并具有可直接使用的丰富的内置动作库。例如OCR识别,文本屏幕快照翻译,批处理重命名,快速本地搜索,连续复制,图像压缩,快速回复等。

3、摘录

Snipaste是一个用于截图和贴纸的简单而强大的工具。您也可以将屏幕截图粘贴回屏幕。 F1屏幕截图,F3纹理,简约高效。

许多信息将在办公室中复制,并且书写时将复制许多文本和图片。 Snipaste可以将这些内容粘贴到屏幕上,而无需切换回窗口。

Snipaste可以自动检测窗口和元素,从而轻松快速地捕获单个窗口。 Snipaste的自动元素检测功能非常准确。它可以捕获窗口上的按钮或选项,甚至可以捕获网页上的图片或一段文字。

Snipaste支持多种颜色和多种标记。矩形,折线,箭头,笔,标记,马赛克,文本,橡皮擦,支持撤消和重做操作。空格键用于隐藏和显示标记面板。

4、 DropIt

DropIt是一款经典,古老且开源的免费文件批处理组织软件,是一种绝对的生产力工具。您只需要将文件拖到浮动的DropIt图标上,该软件就会以预设形式自动处理文件。

您可以定义用于过滤文件的规则,并关联18个可用选项(移动,复制,压缩,提取,重命名,删除,加密,打开为,上传,通过邮件发送,创建图库,创建列表,创建播放列表,创建快捷键,复制到剪贴板,修改属性并忽略)。

5、桌面日历

桌面日历是Windows上非常强大且易于使用的日历软件。双击以记录每日待办事项。桌面日历可以很好地帮助您管理日常待办事项和计划。桌面日历还提供10,000年的阴历,24个节假日以及各种常见的节日和纪念日。

强大的数据导入和导出功能,设置不同的背景色,云数据同步...桌面日历具有许多有用的功能,等待您进行探索。

6、 优采云 采集器

优采云 采集器由前Google技术团队创建。基于人工智能技术,通过输入URL可以自动识别采集的内容。

可以智能识别数据。智能模式基于人工智能算法。您只需输入URL,就可以智能地识别列表数据,表数据和分页按钮。无需配置任何采集规则,只需一个键采集。自动识别列表,表格,链接,图片,价格等。

流程图模式:只需根据软件提示单击并在页面上进行操作即可,这完全符合人们浏览网络的思维方式,并且只需几个简单的步骤即可生成复杂的采集规则,结合智能识别算法,任何网页数据都可以轻松采集。

可以模拟操作:输入文本,单击,移动鼠标,下拉框,滚动页面,等待加载,循环操作和判断条件等。

7、 QTTabBar

QTTabBar是一个小型工具,使您可以在Windows资源管理器中使用“选项卡”多选项卡功能。从此以后,不再有工作时的文件夹窗口,而是强大的文件夹预览功能,大大提高了工作效率。

另一个功能是快速预览文件和文件夹。您只需要将鼠标悬停在文件上,即可自动预览内容。我测试了视频,音频,GIF图像和PNG图像,没有任何问题。您可以从图片中看到视频时间,证明视频可以播放并且有声音。

像这样管理多个文件夹是否容易得多?您所需要的只是一个窗口,告别凌乱的桌面! QTTabBar还具有许多功能和快捷键,并且浏览器选项卡的快捷键基本上可以在QTTabBar上重复使用。

好的,这是这次共享的所有内容。感谢您在这里看到它。听说三联的朋友都很幸运。如果您喜欢,请单击以关注小智,更多实用的内容正在等您获得!

查看全部

7款非常好用的办公软件,可以极大提高办公效率

与您共享7个非常有用的办公软件,可以大大提高办公效率,每个软件都可以称为精品店,如果您愿意的话,请记住喜欢并给予支持〜

1、清单

Listary是一款功能非常强大的文件浏览,搜索增强,对话框增强软件。第一个功能是快速打开文件和应用程序。您可以在任何界面上双击Ctrl来快速打开目标,而不会最小化当前窗口。搜索结果出现后,默认情况下将首先显示该应用程序,您可以按空格键仅显示文件。

第二个功能是文件浏览器的增强。在资源管理器界面中,您不需要任何快捷键,只需直接按文件名,“列表”搜索框就会自动打开以自动检索文件。

Listary的第三个功能是增强了各种打开/保存对话框。在任何打开/保存/下载对话框界面的底部,将自动吸附Listary的搜索框,并且可以通过直接输入名称来快速定位目标文件夹。

这是快捷键。如果目标文件夹已打开,请按快捷键Ctrl + G在对话框中快速打开该文件夹,方便快捷。

2、更快

Quicker是一种可以提高计算机使用效率的软件。它允许Windows用户以最合适的方式和最快的软件工具触发所需的操作。它是一个基于场景的工具箱,也是一个用于创建和共享新工具平台的工具。

单击鼠标中键(可以设置)以弹出,位置跟随鼠标,并且可以通过移动一小段距离来触发动作。 28个可视化的操作按钮,建立操作快捷方式,快速启动软件并执行操作。

Quicker支持自定义动作,并具有可直接使用的丰富的内置动作库。例如OCR识别,文本屏幕快照翻译,批处理重命名,快速本地搜索,连续复制,图像压缩,快速回复等。

3、摘录

Snipaste是一个用于截图和贴纸的简单而强大的工具。您也可以将屏幕截图粘贴回屏幕。 F1屏幕截图,F3纹理,简约高效。

许多信息将在办公室中复制,并且书写时将复制许多文本和图片。 Snipaste可以将这些内容粘贴到屏幕上,而无需切换回窗口。

Snipaste可以自动检测窗口和元素,从而轻松快速地捕获单个窗口。 Snipaste的自动元素检测功能非常准确。它可以捕获窗口上的按钮或选项,甚至可以捕获网页上的图片或一段文字。

Snipaste支持多种颜色和多种标记。矩形,折线,箭头,笔,标记,马赛克,文本,橡皮擦,支持撤消和重做操作。空格键用于隐藏和显示标记面板。

4、 DropIt

DropIt是一款经典,古老且开源的免费文件批处理组织软件,是一种绝对的生产力工具。您只需要将文件拖到浮动的DropIt图标上,该软件就会以预设形式自动处理文件。

您可以定义用于过滤文件的规则,并关联18个可用选项(移动,复制,压缩,提取,重命名,删除,加密,打开为,上传,通过邮件发送,创建图库,创建列表,创建播放列表,创建快捷键,复制到剪贴板,修改属性并忽略)。

5、桌面日历

桌面日历是Windows上非常强大且易于使用的日历软件。双击以记录每日待办事项。桌面日历可以很好地帮助您管理日常待办事项和计划。桌面日历还提供10,000年的阴历,24个节假日以及各种常见的节日和纪念日。

强大的数据导入和导出功能,设置不同的背景色,云数据同步...桌面日历具有许多有用的功能,等待您进行探索。

6、 优采云 采集器

优采云 采集器由前Google技术团队创建。基于人工智能技术,通过输入URL可以自动识别采集的内容。

可以智能识别数据。智能模式基于人工智能算法。您只需输入URL,就可以智能地识别列表数据,表数据和分页按钮。无需配置任何采集规则,只需一个键采集。自动识别列表,表格,链接,图片,价格等。

流程图模式:只需根据软件提示单击并在页面上进行操作即可,这完全符合人们浏览网络的思维方式,并且只需几个简单的步骤即可生成复杂的采集规则,结合智能识别算法,任何网页数据都可以轻松采集。

可以模拟操作:输入文本,单击,移动鼠标,下拉框,滚动页面,等待加载,循环操作和判断条件等。

7、 QTTabBar

QTTabBar是一个小型工具,使您可以在Windows资源管理器中使用“选项卡”多选项卡功能。从此以后,不再有工作时的文件夹窗口,而是强大的文件夹预览功能,大大提高了工作效率。

另一个功能是快速预览文件和文件夹。您只需要将鼠标悬停在文件上,即可自动预览内容。我测试了视频,音频,GIF图像和PNG图像,没有任何问题。您可以从图片中看到视频时间,证明视频可以播放并且有声音。

像这样管理多个文件夹是否容易得多?您所需要的只是一个窗口,告别凌乱的桌面! QTTabBar还具有许多功能和快捷键,并且浏览器选项卡的快捷键基本上可以在QTTabBar上重复使用。

好的,这是这次共享的所有内容。感谢您在这里看到它。听说三联的朋友都很幸运。如果您喜欢,请单击以关注小智,更多实用的内容正在等您获得!

免规则采集器列表算法知识重难点总结(组图)

采集交流 • 优采云 发表了文章 • 0 个评论 • 177 次浏览 • 2021-05-01 18:05

免规则采集器列表算法知识重难点总结采集工具:迅捷抠图采集的重点以及具体设置,我会分享一些相关的课程网课,

推荐一个app叫鸟哥笔记,里面都是前沿技术干货。用了一段时间,所有的采集工具基本上都用过了,没有一个满意的,直到鸟哥笔记提供的采集工具,简单易用好用,对于非科班学习来说,

那应该是要求比较高啦,

现在好像只能去做,国内很多东西都是比较copy,没有自己的产品,例如有采api,但是其实我们也不知道用的人有多少,有的用开源,用的人太少了就不好比较,开源的话如果要成长的快就需要你自己去从小白的角度去做一些东西,做一些东西成长快速些就要去改一些东西,这样效率就慢了,其实我觉得真心只有极个别有实力的团队能做一个产品出来的,我只接触过阿里,因为阿里的产品研发人员薪资都很高,一般的小团队没有那么强的产品能力,就拿阿里那个新业务来说,一个普通的产品经理1年多的经验估计很难弄出一个有特色的产品,所以我自己不认为几千人的公司能够有好的产品团队。

国内来说的话就差不多了,有新闻列表,有新闻大数据,这两者都是十几个人的团队,我在阿里待了一年多,这些团队基本上没有听说过外部的人,这两个在业内都算是比较好的。cf生活圈是一个开放平台,任何团队、个人都可以建立,这个平台我也没有用过,不好说。还有新榜,觉得他们提供的东西量不多,用起来不方便。再次推荐一下teambition和circle。

excel是一个非常实用的工具,基本上相当于一个数据工具吧,对于不会用excel的人,可以花几天时间去学习,熟练之后就能对付绝大部分的数据的处理了。viewer是非常方便的,对于有些喜欢minimal创作的人来说,简直是神器,将来可以成立一个小公司,或者是单独的一个项目。 查看全部

免规则采集器列表算法知识重难点总结(组图)

免规则采集器列表算法知识重难点总结采集工具:迅捷抠图采集的重点以及具体设置,我会分享一些相关的课程网课,

推荐一个app叫鸟哥笔记,里面都是前沿技术干货。用了一段时间,所有的采集工具基本上都用过了,没有一个满意的,直到鸟哥笔记提供的采集工具,简单易用好用,对于非科班学习来说,

那应该是要求比较高啦,

现在好像只能去做,国内很多东西都是比较copy,没有自己的产品,例如有采api,但是其实我们也不知道用的人有多少,有的用开源,用的人太少了就不好比较,开源的话如果要成长的快就需要你自己去从小白的角度去做一些东西,做一些东西成长快速些就要去改一些东西,这样效率就慢了,其实我觉得真心只有极个别有实力的团队能做一个产品出来的,我只接触过阿里,因为阿里的产品研发人员薪资都很高,一般的小团队没有那么强的产品能力,就拿阿里那个新业务来说,一个普通的产品经理1年多的经验估计很难弄出一个有特色的产品,所以我自己不认为几千人的公司能够有好的产品团队。

国内来说的话就差不多了,有新闻列表,有新闻大数据,这两者都是十几个人的团队,我在阿里待了一年多,这些团队基本上没有听说过外部的人,这两个在业内都算是比较好的。cf生活圈是一个开放平台,任何团队、个人都可以建立,这个平台我也没有用过,不好说。还有新榜,觉得他们提供的东西量不多,用起来不方便。再次推荐一下teambition和circle。

excel是一个非常实用的工具,基本上相当于一个数据工具吧,对于不会用excel的人,可以花几天时间去学习,熟练之后就能对付绝大部分的数据的处理了。viewer是非常方便的,对于有些喜欢minimal创作的人来说,简直是神器,将来可以成立一个小公司,或者是单独的一个项目。

织梦优采云采集器免登录文章在线发布模块详细解析

采集交流 • 优采云 发表了文章 • 0 个评论 • 154 次浏览 • 2021-05-01 03:03

尽管织梦 DEDE cms程序不再更新和升级,但是基本的内容管理系统功能或许多人在二次开发后仍在使用它。无可否认,DEDE cms是一个非常易于使用的内容管理系统,尤其是用于生成静态页面的页面,适用于大数据采集。同样,老姜在此文章中整理了可在夜间使用的织梦 DEDE cms 优采云 采集器免登录文章在线发布模块,并在此进行记录,以便您可以在需要时使用它。已使用。

一、安装和调整织梦免登录模块

我们首先在优采云 采集器中下载并导入该模块。该模块是从Internet下载的,以确保可以用于调试。如果还需要,可以在加入QQ组后与我们联系。它不会在这里直接发布。

导入后,我们直接在WEB在线模块中找到5.版本6发行模块。实际上,我们安装了5.版本7,该版本也可用。该模块在Internet上也可用。在调试过程中,我已经问过某个QQ群并收取了费用。其实,问题很简单。请稍后再说。

二、将免登录密码设置为一致

检查[jiekou.php]文件中的密码文件。

在这里,我们的密码可以随意设置,只是在优采云模块中需要保持一致。

一种方法是在列列表中获取密码。

一个是内容发布参数,这三个位置的密码必须保持一致。同时,我们需要将Jiekou.php文件放在我们的后端目录中,该目录默认是dede目录。

三、连接模块获取目录

在这里,我们使用织梦 DEDE cms配置登录地址,并使用不需要登录的HTTP请求模式即可实现无需密码即可直接登录。这里应该注意,我们需要设置DEDE cms支持的PHP版本。如果版本太高,则无法访问。稍后我将对此进行单独介绍。

对于优采云 采集器免登录发布模块,我们必须设置一个更强的密码。如果猜中了,可能会被恶意发布文章。或者,我们可以在发布后删除该文件,然后在需要时添加它,或者我们可以更改免登录文件的文件名。

总结,以上是测试,可以被老姜使用织梦 DEDE cms 优采云 采集器使用免登录的文章释放模块确实是可用的,问题出在需要的PHP版本较低的版本,因为DEDE cms此模块和DEDE cms支持较低的PHP,毕竟程序较旧。 查看全部

织梦优采云采集器免登录文章在线发布模块详细解析

尽管织梦 DEDE cms程序不再更新和升级,但是基本的内容管理系统功能或许多人在二次开发后仍在使用它。无可否认,DEDE cms是一个非常易于使用的内容管理系统,尤其是用于生成静态页面的页面,适用于大数据采集。同样,老姜在此文章中整理了可在夜间使用的织梦 DEDE cms 优采云 采集器免登录文章在线发布模块,并在此进行记录,以便您可以在需要时使用它。已使用。

一、安装和调整织梦免登录模块

我们首先在优采云 采集器中下载并导入该模块。该模块是从Internet下载的,以确保可以用于调试。如果还需要,可以在加入QQ组后与我们联系。它不会在这里直接发布。

导入后,我们直接在WEB在线模块中找到5.版本6发行模块。实际上,我们安装了5.版本7,该版本也可用。该模块在Internet上也可用。在调试过程中,我已经问过某个QQ群并收取了费用。其实,问题很简单。请稍后再说。

二、将免登录密码设置为一致

检查[jiekou.php]文件中的密码文件。

在这里,我们的密码可以随意设置,只是在优采云模块中需要保持一致。

一种方法是在列列表中获取密码。

一个是内容发布参数,这三个位置的密码必须保持一致。同时,我们需要将Jiekou.php文件放在我们的后端目录中,该目录默认是dede目录。

三、连接模块获取目录

在这里,我们使用织梦 DEDE cms配置登录地址,并使用不需要登录的HTTP请求模式即可实现无需密码即可直接登录。这里应该注意,我们需要设置DEDE cms支持的PHP版本。如果版本太高,则无法访问。稍后我将对此进行单独介绍。

对于优采云 采集器免登录发布模块,我们必须设置一个更强的密码。如果猜中了,可能会被恶意发布文章。或者,我们可以在发布后删除该文件,然后在需要时添加它,或者我们可以更改免登录文件的文件名。

总结,以上是测试,可以被老姜使用织梦 DEDE cms 优采云 采集器使用免登录的文章释放模块确实是可用的,问题出在需要的PHP版本较低的版本,因为DEDE cms此模块和DEDE cms支持较低的PHP,毕竟程序较旧。

免规则采集器列表字符串转义字符列表字典结构长链

采集交流 • 优采云 发表了文章 • 0 个评论 • 183 次浏览 • 2021-05-01 00:04

免规则采集器列表算法原文字符串转义字符列表字典结构长链接:/\(\)\10$,短链接:;\2\n\\2#,nof\d\n,\d,\d,\b\_10^10@f#如何利用字典结构列表快速获取小于10的字符串?????n2:[expr0x1102010110],其中expr为子字符串,\2为非none子字符串,\1为换行。

提高新字符串index靠内置字典列表不太实用,比如能不能把abcdefexistsshortuniqueinteger用在新字符串上??比如要求查字典id,如果在字典里查,就必须知道长度及其索引,如果换成新字符串,只需要知道有多少位元即可(假设当前id为z100,则可以查到长度为100000的id)。

但是用字典,经常要查元素:字典(collection)是一种数据结构,它包含有序列表,通常称为键,中间表达式匹配表达式等。注意要求要求:每个键必须唯一匹配(最多一个,最多多少也有具体要求)。采用字典查查找效率高。根据上面原因,使用列表nofm?,不能采用hash表。另外hash表n位元,m位元,多了不好划分字符。

n3:key_list=[[u'z100',id=100000],[u'z100',id=1000000],[u'z100',id=10000000],[u'z100',id=10000000],[u'z100',id=100000000],[u'z100',id=100000000],[u'z100',id=100000000],[u'z100',id=100000000],[u'z100',id=100000000],[u'z100',id=100000000],[u'z100',id=100000000],[u'z100',id=100000000],[u'z100',id=100000000],[u'z100',id=100000000],[u'z100',id=100000000],[u'z100',id=100000000],[u'z100',id=100000000],[u'z100',id=100000000],[u'z100',id=100000000],[u'z100',id=100000000],[u'z100',id=100000000],[u'z100',id=100000000],[u'z100',id=100000000],[u'z100',id=100000000],[u'z100',id=100000000],[u'z100',id=100000000],[u'z10。 查看全部

免规则采集器列表字符串转义字符列表字典结构长链

免规则采集器列表算法原文字符串转义字符列表字典结构长链接:/\(\)\10$,短链接:;\2\n\\2#,nof\d\n,\d,\d,\b\_10^10@f#如何利用字典结构列表快速获取小于10的字符串?????n2:[expr0x1102010110],其中expr为子字符串,\2为非none子字符串,\1为换行。

提高新字符串index靠内置字典列表不太实用,比如能不能把abcdefexistsshortuniqueinteger用在新字符串上??比如要求查字典id,如果在字典里查,就必须知道长度及其索引,如果换成新字符串,只需要知道有多少位元即可(假设当前id为z100,则可以查到长度为100000的id)。

但是用字典,经常要查元素:字典(collection)是一种数据结构,它包含有序列表,通常称为键,中间表达式匹配表达式等。注意要求要求:每个键必须唯一匹配(最多一个,最多多少也有具体要求)。采用字典查查找效率高。根据上面原因,使用列表nofm?,不能采用hash表。另外hash表n位元,m位元,多了不好划分字符。

n3:key_list=[[u'z100',id=100000],[u'z100',id=1000000],[u'z100',id=10000000],[u'z100',id=10000000],[u'z100',id=100000000],[u'z100',id=100000000],[u'z100',id=100000000],[u'z100',id=100000000],[u'z100',id=100000000],[u'z100',id=100000000],[u'z100',id=100000000],[u'z100',id=100000000],[u'z100',id=100000000],[u'z100',id=100000000],[u'z100',id=100000000],[u'z100',id=100000000],[u'z100',id=100000000],[u'z100',id=100000000],[u'z100',id=100000000],[u'z100',id=100000000],[u'z100',id=100000000],[u'z100',id=100000000],[u'z100',id=100000000],[u'z100',id=100000000],[u'z100',id=100000000],[u'z100',id=100000000],[u'z10。

第一個問題和已有問題重複:如何识别並提取网页正文?

采集交流 • 优采云 发表了文章 • 0 个评论 • 153 次浏览 • 2021-04-30 07:25

第一个问题与现有问题相同:如何识别和提取网页正文?

我写的第二个问题是一个简单的分词算法,顺便说一下,提取频率较高的词作为关键词。即使是一个非常简单的算法,也适用于大多数网页。

有很多现成的分词算法,您可以搜索;

有很多现成的关键词提取,可以搜索。 。

第二个问题似乎也与现有问题重复。

我之前在php中编写了一个采集插件。这称为网页正文提取。

算法大致如下:

1、将网页分成许多DOM块。

2、分解的dom块。您必须使用某些标准来丢弃和排除。例如,在某些dom禁食中,有很多链接,这些链接通常是列表。可以丢弃。还要计算文本密度的比率(text / html)。例如,标签的百分比,例如(span,p,a,font)。等一下,经过多次过滤后,最终会剩下几个dom块。然后根据某些规则过滤掉。正确率会比较高。

最重要的值也可以用作参考。我在纸上看到了文字,并在段落中使用了句号来对其进行判断。

如果一段大段文字中收录很多句号,则表示此dom快可能是因为内容很快。

我以前写过Java版的采集器(Gworm),但我有一个卑鄙的见解。如果仅提供一个URL,仍然很难以智能方式提取网页的文章部分(这并非不可能,只需使用统计概率的方法就不能100%正确)。因此,我以前的计划是使用css选择器提取内容,而不是自己手写正则表达式。一个css样式名称网站通常非常稳定,因此只需要网站的所有文章提取规则,以及获得文章标记的第二个问题,也可以通过以下方式轻松解决使用css选择器。由于该主题使用python爬行,因此我不知道python必须提供哪个库来提供DOM上的CSS选择功能,但我相信一定有,与我使用的Java版本的CSS选择器相对应的是Jsoup。

更新:我只是用Google搜索“ python CSS选择器”和很多结果。看看这篇文章文章。

在python中有pyquery

php有phpquery

使用jquery语法进行处理非常方便

python中有一个scrapy框架,非常好,还有scrapinghub云平台,可以节省很多工作;

对于抓取标签,它涉及分类和聚类算法。这里有很多选择

如果数据量不大,请使用可读性api来避免麻烦。

建议不要使用常规规则进行html解析,了解lxml,然后在chrome浏览器的开发模式下,可以直接在lxml中复制与DOM节点相对应的xpath,这样可以节省很多时间,和lxml解析html,提高xml的性能

免责声明:本文原创已发布在php中文网站上。请注明转载来源。谢谢您的尊重!如有任何疑问,请与我们联系 查看全部

第一個問題和已有問題重複:如何识别並提取网页正文?

第一个问题与现有问题相同:如何识别和提取网页正文?

我写的第二个问题是一个简单的分词算法,顺便说一下,提取频率较高的词作为关键词。即使是一个非常简单的算法,也适用于大多数网页。

有很多现成的分词算法,您可以搜索;

有很多现成的关键词提取,可以搜索。 。

第二个问题似乎也与现有问题重复。

我之前在php中编写了一个采集插件。这称为网页正文提取。

算法大致如下:

1、将网页分成许多DOM块。

2、分解的dom块。您必须使用某些标准来丢弃和排除。例如,在某些dom禁食中,有很多链接,这些链接通常是列表。可以丢弃。还要计算文本密度的比率(text / html)。例如,标签的百分比,例如(span,p,a,font)。等一下,经过多次过滤后,最终会剩下几个dom块。然后根据某些规则过滤掉。正确率会比较高。

最重要的值也可以用作参考。我在纸上看到了文字,并在段落中使用了句号来对其进行判断。

如果一段大段文字中收录很多句号,则表示此dom快可能是因为内容很快。

我以前写过Java版的采集器(Gworm),但我有一个卑鄙的见解。如果仅提供一个URL,仍然很难以智能方式提取网页的文章部分(这并非不可能,只需使用统计概率的方法就不能100%正确)。因此,我以前的计划是使用css选择器提取内容,而不是自己手写正则表达式。一个css样式名称网站通常非常稳定,因此只需要网站的所有文章提取规则,以及获得文章标记的第二个问题,也可以通过以下方式轻松解决使用css选择器。由于该主题使用python爬行,因此我不知道python必须提供哪个库来提供DOM上的CSS选择功能,但我相信一定有,与我使用的Java版本的CSS选择器相对应的是Jsoup。

更新:我只是用Google搜索“ python CSS选择器”和很多结果。看看这篇文章文章。

在python中有pyquery

php有phpquery

使用jquery语法进行处理非常方便

python中有一个scrapy框架,非常好,还有scrapinghub云平台,可以节省很多工作;

对于抓取标签,它涉及分类和聚类算法。这里有很多选择

如果数据量不大,请使用可读性api来避免麻烦。

建议不要使用常规规则进行html解析,了解lxml,然后在chrome浏览器的开发模式下,可以直接在lxml中复制与DOM节点相对应的xpath,这样可以节省很多时间,和lxml解析html,提高xml的性能

免责声明:本文原创已发布在php中文网站上。请注明转载来源。谢谢您的尊重!如有任何疑问,请与我们联系

免规则采集器列表算法:1、2-5页

采集交流 • 优采云 发表了文章 • 0 个评论 • 276 次浏览 • 2021-04-21 23:01

免规则采集器列表算法:

1、采集器本身页面可以是url地址

2、会自动转为html地址

3、所有页面都会转化为png图片

4、正则表达式

5、普通正则表达式

6、自定义正则表达式正则采集后,首先需要发送采集器服务器,被采集的网页一般是excel中的数据采集规则库内容为每页采集1条数据,但可采集2-5页。

操作如下:

1、在浏览器的地址栏(地址栏是自定义的http)输入,

2、生成采集规则

3、在采集规则里面填写内容正则表达式将上面正则表达式填写到规则库内,然后点击采集。

可以从网页中得到网页的url,ip,访问深度,

有公共url和无公共url爬虫的不同之处在于公共url可以爬取百度,360,

<p>#includeintmain(){std::cout 查看全部

免规则采集器列表算法:1、2-5页

免规则采集器列表算法:

1、采集器本身页面可以是url地址

2、会自动转为html地址

3、所有页面都会转化为png图片

4、正则表达式

5、普通正则表达式

6、自定义正则表达式正则采集后,首先需要发送采集器服务器,被采集的网页一般是excel中的数据采集规则库内容为每页采集1条数据,但可采集2-5页。

操作如下:

1、在浏览器的地址栏(地址栏是自定义的http)输入,

2、生成采集规则

3、在采集规则里面填写内容正则表达式将上面正则表达式填写到规则库内,然后点击采集。

可以从网页中得到网页的url,ip,访问深度,

有公共url和无公共url爬虫的不同之处在于公共url可以爬取百度,360,

<p>#includeintmain(){std::cout

免规则采集器列表:支持批量修改内容多样化的行和列特点

采集交流 • 优采云 发表了文章 • 0 个评论 • 188 次浏览 • 2021-04-13 20:06

免规则采集器列表算法:采集器列表采集:支持简易列表采集,支持任意列表文件的下载,支持任意文件类型的下载或是批量下载,支持任意文件的打包下载、转换工具包下载、压缩包下载等等特点:支持任意文件类型的下载,支持任意文件类型的批量下载特点:支持批量上传图片,批量支持图片上传无需第三方提供开源图片,采集软件自身已经上传图片。

你可以在st服务器打开指定文件,或下载你指定文件,或上传指定文件,并批量指定处理器(如java-convert或java-toarrays等)。支持批量修改内容特点:支持批量修改内容多样化的行和列特点:支持批量下载各种文件和图片工具包和服务器内部采集算法多样化设置,快速进行功能设置,并且可以快速转换到本地;在有条件情况下,可以支持共享功能设置和布局共享:链接(一种交换方式)和其他共享链接,将本地接收到的所有链接存放到自己的服务器,本地这样处理所有的链接异步修改:按forward或者post进行内容修改修改:如果想查看到修改后的内容,可以修改list或者header中,添加yes表示修改成功非法地址修改:因为某些不需要修改的内容没有自己解析入格式或者没有提供解析的页面,可以使用非法地址进行修改;会提示该页面未经本地验证;无法获取保存在服务器端的修改(修改后)和查看原始页面信息数据;无法了解修改后的内容的相关信息采集完成后,可以根据自己的需要进行第三方的处理:常见的如:重复、分页、取值、统计等等还有更多采集工具列表大家可以关注我的个人网站和博客。 查看全部

免规则采集器列表:支持批量修改内容多样化的行和列特点

免规则采集器列表算法:采集器列表采集:支持简易列表采集,支持任意列表文件的下载,支持任意文件类型的下载或是批量下载,支持任意文件的打包下载、转换工具包下载、压缩包下载等等特点:支持任意文件类型的下载,支持任意文件类型的批量下载特点:支持批量上传图片,批量支持图片上传无需第三方提供开源图片,采集软件自身已经上传图片。

你可以在st服务器打开指定文件,或下载你指定文件,或上传指定文件,并批量指定处理器(如java-convert或java-toarrays等)。支持批量修改内容特点:支持批量修改内容多样化的行和列特点:支持批量下载各种文件和图片工具包和服务器内部采集算法多样化设置,快速进行功能设置,并且可以快速转换到本地;在有条件情况下,可以支持共享功能设置和布局共享:链接(一种交换方式)和其他共享链接,将本地接收到的所有链接存放到自己的服务器,本地这样处理所有的链接异步修改:按forward或者post进行内容修改修改:如果想查看到修改后的内容,可以修改list或者header中,添加yes表示修改成功非法地址修改:因为某些不需要修改的内容没有自己解析入格式或者没有提供解析的页面,可以使用非法地址进行修改;会提示该页面未经本地验证;无法获取保存在服务器端的修改(修改后)和查看原始页面信息数据;无法了解修改后的内容的相关信息采集完成后,可以根据自己的需要进行第三方的处理:常见的如:重复、分页、取值、统计等等还有更多采集工具列表大家可以关注我的个人网站和博客。

基于treesearch的一种非常强大的免规则采集器列表算法

采集交流 • 优采云 发表了文章 • 0 个评论 • 204 次浏览 • 2021-04-08 20:01

免规则采集器列表算法是基于treesearch的一种非常强大的排序算法,利用这种算法可以很好的按照规则对元素进行排序,非常的高效。

1、定义treesorter类

2、定义相关方法,

3、实现treesorter类的主要方法treesorter类最主要的功能,

4、构建treesorter类staticclasstreesorter{//定义初始化参数}最基本的okr规则采集器是一个列表,集合中既存放当前阶段所采集到的规则,也存放当前正在执行采集到的规则;publicinterfacetreesorter{//定义采集阶段;listdown;//定义采集成果;listup;//标注采集不同阶段的时间sequencetimes;//规则列表;listtags;//规则总结stringtypes;//算法子列表;dequequeries;//同步异步;listannotations;//规则获取;booleancache;//规则记录;intcount;//规则次数writestring();//规则读取,异步等;addcolumn();//添加规则;stringcount;//规则总结stringcachesize;//规则总共列表个数;}3。

<p>2apply子方法;listapply;//注册规则;datetimeinit(){listqueries;for(inti=0;i 查看全部

基于treesearch的一种非常强大的免规则采集器列表算法

免规则采集器列表算法是基于treesearch的一种非常强大的排序算法,利用这种算法可以很好的按照规则对元素进行排序,非常的高效。

1、定义treesorter类

2、定义相关方法,

3、实现treesorter类的主要方法treesorter类最主要的功能,

4、构建treesorter类staticclasstreesorter{//定义初始化参数}最基本的okr规则采集器是一个列表,集合中既存放当前阶段所采集到的规则,也存放当前正在执行采集到的规则;publicinterfacetreesorter{//定义采集阶段;listdown;//定义采集成果;listup;//标注采集不同阶段的时间sequencetimes;//规则列表;listtags;//规则总结stringtypes;//算法子列表;dequequeries;//同步异步;listannotations;//规则获取;booleancache;//规则记录;intcount;//规则次数writestring();//规则读取,异步等;addcolumn();//添加规则;stringcount;//规则总结stringcachesize;//规则总共列表个数;}3。

<p>2apply子方法;listapply;//注册规则;datetimeinit(){listqueries;for(inti=0;i

免规则采集器列表算法及对照:采集商品到打开jsoup方法

采集交流 • 优采云 发表了文章 • 0 个评论 • 191 次浏览 • 2021-04-08 18:04

免规则采集器列表算法及对照:制定规则采集下来的列表,最后按照指定的列表长度放回不同的排序列表。实例:采集商品到excel打开jsoup方法:google搜索下面搜索“云朵列表采集器-freestyle5-”(能在线部署网页项目)采集代码:先获取云朵列表列表api接口参数://返回key值是一个数组,[x,y]为输入采集参数//x为分页列表[1],int为分页数量.y是一个以class="key"开头的键值对[1,2,3]示例key参数在pages-1中key=xraw_request_url=""//key值为拼接的key值//y为拼接的分页名字[1,2,3]//获取每一页的列表最新的列表[1,2,3]//获取第一页查询服务器响应是有且只有两个请求[http-server]method="post"\[key]#返回urlpages=getfile(request_url).get_some_pages()cookie是客户端登录后,直接存储到客户端的cookie中,需要通过https模式来发送。

[cookie]response=http(request_url,headers=headers).transform(cookie=response)完成采集列表headers参数不同返回可能不同form-data中也可能提交不同格式:onedataresponseversion:由此返回的返回值本身所对应的响应大小url:存储在本地网页缓存中的响应urlusername:用户名,发送请求时根据该用户发送请求的username,去请求服务器,根据请求返回的响应username,返回一个响应值,有msg(是否用户查询过程中有改变useragent或浏览器变化?)position:对端发送的某个页面内容的各个位置的名称proxy:请求服务器时,请求网站是默认的端口是3306username1:用户发送请求时,根据该用户提交了一个username请求服务器,来返回该页面的username页的sqlitedata列表infourl:网页列表的信息,不是列表的名称,而是一些可能得列表名称,列表的行也可以提交list列表username列表mallocallback:这个请求服务器响应username列表的提交请求的完整列表列表总结:对照主要实现思路,整体的来理解下jsoup采集列表的细节方法是基于键值对,键在内容中的不同,按照不同个序列值列出来,对于每个列表的值都可以知道列表值组成了何种列表,而每个值相当于从列表里取一个列表,依次往列表里加即可,每个列表值都是包含很多个“item”,每个item对应一个值而已。

我们可以理解为每一个列表只有一个值,也就是一个向量,依次取值而已frequency:frequency为参数,返回当前请求列表的秒数(秒为对应的空)request:request为参数,返回目标列表,可以直接连接相同的列表服务器。 查看全部

免规则采集器列表算法及对照:采集商品到打开jsoup方法

免规则采集器列表算法及对照:制定规则采集下来的列表,最后按照指定的列表长度放回不同的排序列表。实例:采集商品到excel打开jsoup方法:google搜索下面搜索“云朵列表采集器-freestyle5-”(能在线部署网页项目)采集代码:先获取云朵列表列表api接口参数://返回key值是一个数组,[x,y]为输入采集参数//x为分页列表[1],int为分页数量.y是一个以class="key"开头的键值对[1,2,3]示例key参数在pages-1中key=xraw_request_url=""//key值为拼接的key值//y为拼接的分页名字[1,2,3]//获取每一页的列表最新的列表[1,2,3]//获取第一页查询服务器响应是有且只有两个请求[http-server]method="post"\[key]#返回urlpages=getfile(request_url).get_some_pages()cookie是客户端登录后,直接存储到客户端的cookie中,需要通过https模式来发送。

[cookie]response=http(request_url,headers=headers).transform(cookie=response)完成采集列表headers参数不同返回可能不同form-data中也可能提交不同格式:onedataresponseversion:由此返回的返回值本身所对应的响应大小url:存储在本地网页缓存中的响应urlusername:用户名,发送请求时根据该用户发送请求的username,去请求服务器,根据请求返回的响应username,返回一个响应值,有msg(是否用户查询过程中有改变useragent或浏览器变化?)position:对端发送的某个页面内容的各个位置的名称proxy:请求服务器时,请求网站是默认的端口是3306username1:用户发送请求时,根据该用户提交了一个username请求服务器,来返回该页面的username页的sqlitedata列表infourl:网页列表的信息,不是列表的名称,而是一些可能得列表名称,列表的行也可以提交list列表username列表mallocallback:这个请求服务器响应username列表的提交请求的完整列表列表总结:对照主要实现思路,整体的来理解下jsoup采集列表的细节方法是基于键值对,键在内容中的不同,按照不同个序列值列出来,对于每个列表的值都可以知道列表值组成了何种列表,而每个值相当于从列表里取一个列表,依次往列表里加即可,每个列表值都是包含很多个“item”,每个item对应一个值而已。

我们可以理解为每一个列表只有一个值,也就是一个向量,依次取值而已frequency:frequency为参数,返回当前请求列表的秒数(秒为对应的空)request:request为参数,返回目标列表,可以直接连接相同的列表服务器。

辣鸡采集基于fesiong优采云采集器开发语言官网案例

采集交流 • 优采云 发表了文章 • 0 个评论 • 192 次浏览 • 2021-04-03 04:08

Laji-collect 采集香辣鸡肉的介绍

辣子鸡采集,采集世界上所有辣子鸡数据都欢迎大家使用采集

基于fesiong 优采云 采集器底部展开

优采云 采集器

开发语言

golang

官方网站案例

辣鸡采集

为什么这辣鸡文章 采集器辣鸡文章 采集器可以采集什么含量

可以作为采集的采集器内容包括:文章标题,文章 关键词,文章说明,文章详细信息,文章作者,文章发布时间,文章次网页浏览。

我什么时候需要使用辣鸡肉文章 采集器

当我们需要给网站 采集 文章时,这个采集器可以派上用场,这个采集器不需要有人值守,它每天24小时运行,每10分钟运行一次自动遍历采集列表,获取收录文章的链接,并随时获取文本。您还可以设置自动发布以自动发布到指定的文章表。

文章 采集器辣鸡在哪里跑?

此采集器可以在Windows系统,Mac系统,Linux系统(Centos,Ubuntu等)上运行,您可以下载已编译的程序以直接执行,也可以下载源代码并自己进行编译。

辣鸡文章 采集器是否可用伪原创

此采集器暂时不支持伪原创功能,稍后将添加适当的伪原创选项。

如何安装和使用

go env -w GOPROXY=https://goproxy.cn,direct

最后执行以下命令

编译结束后,运行编译的文件,然后双击运行可执行文件,在打开的浏览器的可视化界面中填写数据库信息,完成初始配置,添加采集源,然后您可以开始采集的旅程。

发展计划官方网站微信交流小组

帮助改进

欢迎有能力和精神的个人或团体参与此采集器的开发和改进,并共同改善采集的功能。请派生一个分支,然后对其进行修改,并在修改后提交合并请求合并请求。 查看全部

辣鸡采集基于fesiong优采云采集器开发语言官网案例

Laji-collect 采集香辣鸡肉的介绍

辣子鸡采集,采集世界上所有辣子鸡数据都欢迎大家使用采集

基于fesiong 优采云 采集器底部展开

优采云 采集器

开发语言

golang

官方网站案例

辣鸡采集

为什么这辣鸡文章 采集器辣鸡文章 采集器可以采集什么含量

可以作为采集的采集器内容包括:文章标题,文章 关键词,文章说明,文章详细信息,文章作者,文章发布时间,文章次网页浏览。

我什么时候需要使用辣鸡肉文章 采集器

当我们需要给网站 采集 文章时,这个采集器可以派上用场,这个采集器不需要有人值守,它每天24小时运行,每10分钟运行一次自动遍历采集列表,获取收录文章的链接,并随时获取文本。您还可以设置自动发布以自动发布到指定的文章表。

文章 采集器辣鸡在哪里跑?

此采集器可以在Windows系统,Mac系统,Linux系统(Centos,Ubuntu等)上运行,您可以下载已编译的程序以直接执行,也可以下载源代码并自己进行编译。

辣鸡文章 采集器是否可用伪原创

此采集器暂时不支持伪原创功能,稍后将添加适当的伪原创选项。

如何安装和使用

go env -w GOPROXY=https://goproxy.cn,direct

最后执行以下命令

编译结束后,运行编译的文件,然后双击运行可执行文件,在打开的浏览器的可视化界面中填写数据库信息,完成初始配置,添加采集源,然后您可以开始采集的旅程。

发展计划官方网站微信交流小组

帮助改进

欢迎有能力和精神的个人或团体参与此采集器的开发和改进,并共同改善采集的功能。请派生一个分支,然后对其进行修改,并在修改后提交合并请求合并请求。

免规则采集器算法:位信息属性采集-ksf_g151

采集交流 • 优采云 发表了文章 • 0 个评论 • 292 次浏览 • 2021-04-02 22:01

免规则采集器列表算法:(#)位信息属性采集-ksf_g151;简单采集方法:(#)位信息属性采集-ksf_g151_r_5;class_acronyms原子化采集-ksf_g151_sec=sec;class_acronyms布尔值采集-ksf_g151_pi;plaintext属性采集-ksf_g151_chi3;plaintext属性采集-ksf_g151_f_6;plaintext参数采集-ksf_g151_size;__data_hash_chain简单属性采集(不可重复):(#)__foo(__shortcode:12。

8)->__foo(__longcode:12

8);int表示采集数组,

1、(#)__foo(__shortcode:12

2、(#)__foo(__shortcode:12

3、(#)__foo(__shortcode:12

4、(#)__foo(__shortcode:12

5、(#)__foo(__shortcode:12

6、(#)__foo(__shortcode:12

8);int表示采集数组,有多个属性可以用这个list属性列表reflection_ksf_g151是对采集过程中参数传递采用mockjs封装,参数采用key标识数据,采集过程采用对象传递,方便采集分析统计, 查看全部

免规则采集器算法:位信息属性采集-ksf_g151

免规则采集器列表算法:(#)位信息属性采集-ksf_g151;简单采集方法:(#)位信息属性采集-ksf_g151_r_5;class_acronyms原子化采集-ksf_g151_sec=sec;class_acronyms布尔值采集-ksf_g151_pi;plaintext属性采集-ksf_g151_chi3;plaintext属性采集-ksf_g151_f_6;plaintext参数采集-ksf_g151_size;__data_hash_chain简单属性采集(不可重复):(#)__foo(__shortcode:12。

8)->__foo(__longcode:12

8);int表示采集数组,

1、(#)__foo(__shortcode:12

2、(#)__foo(__shortcode:12

3、(#)__foo(__shortcode:12

4、(#)__foo(__shortcode:12

5、(#)__foo(__shortcode:12

6、(#)__foo(__shortcode:12

8);int表示采集数组,有多个属性可以用这个list属性列表reflection_ksf_g151是对采集过程中参数传递采用mockjs封装,参数采用key标识数据,采集过程采用对象传递,方便采集分析统计,

大批量获取详情页的智能抽取结果(可选)

采集交流 • 优采云 发表了文章 • 0 个评论 • 187 次浏览 • 2021-04-01 19:21

一个小概念:

大多数网站以列表页面和详细信息页面的层次结构进行组织。例如,当我们进入新浪新闻频道时,有很多标题链接,可以将其视为列表页面。单击标题链接后,进入详细信息页面。

使用data 采集工具的一般目的是在详细信息页面中获取大量特定的内容数据,并将这些数据用于各种分析,发布自己的网站等。

列表页面:指的是列或目录页面,通常收录多个标题链接。例如:网站第一页或列页面是列表页面。主要功能:您可以通过列表页面获得到多个详细信息页面的链接。

详细信息页面:收录特定内容的页面,例如网页文章,其中收录:标题,作者,出版日期,正文内容,标签等。

要开始,请登录“ 优采云控制面板”:

第一步:创建采集任务

单击左侧菜单按钮“创建采集任务”,输入采集任务名称和您要采集的“列表页面”的URL,例如:(此处的主页是列表页面:内容收录多个详细信息页面是),详细信息页面链接可以保留为空白,系统会自动识别它。

如下所示:

输入后,单击“下一步”。

第2步:改善列表页面的智能提取结果(可选)

系统将首先使用智能算法来获取需要采集的详细信息页面链接(多个)。用户可以双击打开支票。如果您不需要数据,则可以单击“列表提取器”以手动指定它,仅在可视化文件中。用鼠标在界面上单击。

智能采集的结果如下所示:

此外:在以上结果中,系统还智能地找到了翻页规则,用户可以将采集设置为多少页。您也可以稍后在任务“基本信息和门户URL”-“根据规则生成URL”项中对其进行配置。

打开列表提取器后的下图:

第3步:改善明细页的智能提取结果(可选)

在上一步中获得多个详细信息页面链接后,继续进行下一步。系统将使用详细页面链接之一来智能地提取详细页面数据(例如:标题,作者,发布日期,内容,标签等)

详细信息页面的智能提取结果如下:

如果智能提取的内容不是您想要的,则可以打开“详细信息提取器”进行修改。

如下所示:

您可以修改,添加或删除左侧的字段。

您还可以为每个字段(双击字段)执行详细的设置或数据处理:替换,提取,过滤,设置默认值等,

如下所示:

第4步:启动并运行

完成后,您可以开始操作并继续处理数据采集:

采集之后的数据结果,在采集任务的“结果数据和发布”中,您可以在此处修改数据或直接导出excel或发布您的网站(WordPress,织梦 DEDE, HTTP接口,数据库等)。

完成,数据采集就这么简单! ! ! 查看全部

大批量获取详情页的智能抽取结果(可选)

一个小概念:

大多数网站以列表页面和详细信息页面的层次结构进行组织。例如,当我们进入新浪新闻频道时,有很多标题链接,可以将其视为列表页面。单击标题链接后,进入详细信息页面。

使用data 采集工具的一般目的是在详细信息页面中获取大量特定的内容数据,并将这些数据用于各种分析,发布自己的网站等。

列表页面:指的是列或目录页面,通常收录多个标题链接。例如:网站第一页或列页面是列表页面。主要功能:您可以通过列表页面获得到多个详细信息页面的链接。

详细信息页面:收录特定内容的页面,例如网页文章,其中收录:标题,作者,出版日期,正文内容,标签等。

要开始,请登录“ 优采云控制面板”:

第一步:创建采集任务

单击左侧菜单按钮“创建采集任务”,输入采集任务名称和您要采集的“列表页面”的URL,例如:(此处的主页是列表页面:内容收录多个详细信息页面是),详细信息页面链接可以保留为空白,系统会自动识别它。

如下所示:

输入后,单击“下一步”。

第2步:改善列表页面的智能提取结果(可选)

系统将首先使用智能算法来获取需要采集的详细信息页面链接(多个)。用户可以双击打开支票。如果您不需要数据,则可以单击“列表提取器”以手动指定它,仅在可视化文件中。用鼠标在界面上单击。

智能采集的结果如下所示:

此外:在以上结果中,系统还智能地找到了翻页规则,用户可以将采集设置为多少页。您也可以稍后在任务“基本信息和门户URL”-“根据规则生成URL”项中对其进行配置。

打开列表提取器后的下图:

第3步:改善明细页的智能提取结果(可选)

在上一步中获得多个详细信息页面链接后,继续进行下一步。系统将使用详细页面链接之一来智能地提取详细页面数据(例如:标题,作者,发布日期,内容,标签等)

详细信息页面的智能提取结果如下:

如果智能提取的内容不是您想要的,则可以打开“详细信息提取器”进行修改。

如下所示:

您可以修改,添加或删除左侧的字段。

您还可以为每个字段(双击字段)执行详细的设置或数据处理:替换,提取,过滤,设置默认值等,

如下所示:

第4步:启动并运行

完成后,您可以开始操作并继续处理数据采集:

采集之后的数据结果,在采集任务的“结果数据和发布”中,您可以在此处修改数据或直接导出excel或发布您的网站(WordPress,织梦 DEDE, HTTP接口,数据库等)。

完成,数据采集就这么简单! ! !

功能介绍什么是高精度的文章采集软件,效果如何一试就知

采集交流 • 优采云 发表了文章 • 0 个评论 • 223 次浏览 • 2021-03-26 07:24

通用文章 采集器是一款方便易用的文章 采集软件,具有强大的功能并且完全免费使用。该软件易于操作,可以准确地提取网页的正文并将其另存为文章,并支持格式处理,例如标签,链接,电子邮件等。采集只需几分钟您想要文章]。此外,它具有专有的第一个智能通用算法,只需输入关键字即可采集各种网页和新闻,并且采集在列表页面(列页面)上指定文章以准确地提取网页另存为文章内容。同时,具有插入关键词的功能,可以识别标签或标点符号的插入,可以识别英语空格的插入,还具有文章翻译的功能,这意味着您可以将文章从一种语言(例如中文)转换为另一种语言(例如英语或日语),然后从英语或日语转换回中文,这是一个翻译周期,您可以设置多次翻译周期。如果您对某个关键词 文章感兴趣并想要分批下载,则可以使用此完全免费的优采云 Universal 文章 采集器,欢迎有需要的用户下载!

通用文章 采集器软件功能一、依靠优采云软件独有的通用文本识别智能算法,它可以自动提取任何网页文本,准确率超过95%。

二、只需输入关键词,然后采集可以转到百度新闻和网页,搜狗新闻和网页,360新闻和网页,Google新闻和网页,必应新闻和网页,雅虎;批量可用关键词全自动采集。

三、可以指示采集在网站列列表下指定所有文章,智能匹配,无需编写复杂的规则。

四、 文章翻译功能,可以将采集好文章翻译成英文,然后再翻译回中文,实现翻译伪原创,支持Google和Youdao翻译。

五、历史文章 采集器中最简单,最智能的功能,它支持全功能的试用版,您将知道它的工作原理!通用文章 采集器函数介绍了什么是高精度文本识别算法

优采云独立研究和开发了该算法,该算法可以从网页中提取身体部位,其准确度通常为95%。如果进一步设置最小字数,则采集的文章的准确性(正确性)可以达到99%。同时,文章标题也实现了99%的提取精度。当然,当某些网页的布局格式混乱且不规则时,准确性可能会降低。

文本提取模式

文本提取算法具有3种模式:标准,严格和精确标记。在大多数情况下,标准模式和严格模式是相同的提取结果。以下是一些特殊情况:

标准模式:这是常规提取。在大多数情况下,可以准确地提取文本,但是某些特殊页面会导致提取一些不必要的内容(但是这种模式可以更好地识别文章页面,类似于百度的经验)

<p>严格模式:顾名思义,它比标准模式要严格一些,它可以很大程度上避免提取无关内容作为主要文本,但是对于特殊的细分页面,例如百度体验页面(不通用 查看全部

功能介绍什么是高精度的文章采集软件,效果如何一试就知

通用文章 采集器是一款方便易用的文章 采集软件,具有强大的功能并且完全免费使用。该软件易于操作,可以准确地提取网页的正文并将其另存为文章,并支持格式处理,例如标签,链接,电子邮件等。采集只需几分钟您想要文章]。此外,它具有专有的第一个智能通用算法,只需输入关键字即可采集各种网页和新闻,并且采集在列表页面(列页面)上指定文章以准确地提取网页另存为文章内容。同时,具有插入关键词的功能,可以识别标签或标点符号的插入,可以识别英语空格的插入,还具有文章翻译的功能,这意味着您可以将文章从一种语言(例如中文)转换为另一种语言(例如英语或日语),然后从英语或日语转换回中文,这是一个翻译周期,您可以设置多次翻译周期。如果您对某个关键词 文章感兴趣并想要分批下载,则可以使用此完全免费的优采云 Universal 文章 采集器,欢迎有需要的用户下载!

通用文章 采集器软件功能一、依靠优采云软件独有的通用文本识别智能算法,它可以自动提取任何网页文本,准确率超过95%。

二、只需输入关键词,然后采集可以转到百度新闻和网页,搜狗新闻和网页,360新闻和网页,Google新闻和网页,必应新闻和网页,雅虎;批量可用关键词全自动采集。

三、可以指示采集在网站列列表下指定所有文章,智能匹配,无需编写复杂的规则。

四、 文章翻译功能,可以将采集好文章翻译成英文,然后再翻译回中文,实现翻译伪原创,支持Google和Youdao翻译。

五、历史文章 采集器中最简单,最智能的功能,它支持全功能的试用版,您将知道它的工作原理!通用文章 采集器函数介绍了什么是高精度文本识别算法

优采云独立研究和开发了该算法,该算法可以从网页中提取身体部位,其准确度通常为95%。如果进一步设置最小字数,则采集的文章的准确性(正确性)可以达到99%。同时,文章标题也实现了99%的提取精度。当然,当某些网页的布局格式混乱且不规则时,准确性可能会降低。

文本提取模式

文本提取算法具有3种模式:标准,严格和精确标记。在大多数情况下,标准模式和严格模式是相同的提取结果。以下是一些特殊情况:

标准模式:这是常规提取。在大多数情况下,可以准确地提取文本,但是某些特殊页面会导致提取一些不必要的内容(但是这种模式可以更好地识别文章页面,类似于百度的经验)

<p>严格模式:顾名思义,它比标准模式要严格一些,它可以很大程度上避免提取无关内容作为主要文本,但是对于特殊的细分页面,例如百度体验页面(不通用

免规则采集器列表算法很差,赚不到钱

采集交流 • 优采云 发表了文章 • 0 个评论 • 212 次浏览 • 2021-05-18 22:01

免规则采集器列表算法很差,采集可以去百度之类的搜索引擎找别人已经收录的url,对采集器本身要求极高,1个外链覆盖率要求远远大于100个1级外链。其次采集也要分1:1和1:n个比例。这样的规则我本身并不会采集外链,我的外链采集需求是高质量,1个外链覆盖率对技术要求很高。

我个人觉得:比较难了我之前在一家公司是负责百度的采集,我们是按照k计费的,一个外链2刀。我们花了大概3、4k买了百度的产品,然后到现在百度仍然不重视对这方面的重视,当然你也可以说就算只需要k1个外链,按照采集2刀计算,也够卖的了。但是按照k计费,我感觉是限制了采集的人可以采集到的外链,降低了采集的成本。

虽然带来的流量很可观,可是这种采集是必须要经过人工筛选的,很少有一个外链能够覆盖全部链接的,也就是说你的外链总会漏掉些好的、有用的链接。

采集外链其实也可以换句话说就是2个链接加一个外链。2个外链加一个内链加一个好的关键词会在百度的首页上显示出来,而关键词就那么几个。

原来可以这样,我也打算有这个一个采集器插件用来发外链。

百度不重视,赚不到钱我看好多百度账号,绑定了账号来发外链我印象非常深刻。我自己也有。 查看全部

免规则采集器列表算法很差,赚不到钱

免规则采集器列表算法很差,采集可以去百度之类的搜索引擎找别人已经收录的url,对采集器本身要求极高,1个外链覆盖率要求远远大于100个1级外链。其次采集也要分1:1和1:n个比例。这样的规则我本身并不会采集外链,我的外链采集需求是高质量,1个外链覆盖率对技术要求很高。

我个人觉得:比较难了我之前在一家公司是负责百度的采集,我们是按照k计费的,一个外链2刀。我们花了大概3、4k买了百度的产品,然后到现在百度仍然不重视对这方面的重视,当然你也可以说就算只需要k1个外链,按照采集2刀计算,也够卖的了。但是按照k计费,我感觉是限制了采集的人可以采集到的外链,降低了采集的成本。

虽然带来的流量很可观,可是这种采集是必须要经过人工筛选的,很少有一个外链能够覆盖全部链接的,也就是说你的外链总会漏掉些好的、有用的链接。

采集外链其实也可以换句话说就是2个链接加一个外链。2个外链加一个内链加一个好的关键词会在百度的首页上显示出来,而关键词就那么几个。

原来可以这样,我也打算有这个一个采集器插件用来发外链。

百度不重视,赚不到钱我看好多百度账号,绑定了账号来发外链我印象非常深刻。我自己也有。

取消DEDE未登陆时出现的登陆提示自动登陆DEDE修改一处DEDE的代码

采集交流 • 优采云 发表了文章 • 0 个评论 • 152 次浏览 • 2021-05-18 07:31

此方法适用于所有DEDE模型和模块,所有发行模块仅需添加一个配置参数。

实现步骤如下:

取消DEDE未登录时出现的登录提示

自动登录DEDE

在DEDE程序管理员目录中将DEDE代码修改为config.php,默认路径为dede / config.php,代码如下:

//检验用户登录状态 $cuserLogin = new userLogin(); if($cuserLogin->getUserID()==-1) { header("location:login.php?gotopage=".urlencode($dedeNowurl)); exit(); }

此代码的功能是在未检测到用户的登录信息的情况下引导用户进入登录过程,并对其进行如下修改:

//检验用户登录状态 $cuserLogin = new userLogin(); if($cuserLogin->getUserID()==-1) { if($my_u != ''){ $res = $cuserLogin->checkUser($my_u, $my_p); if($res==1) $cuserLogin->keepUser(); } if($cuserLogin->getUserID()==-1) { header("location:login.php?gotopage=".urlencode($dedeNowurl)); exit(); } }

此代码的功能是在检测到用户未登录时尝试使用从页面传递的参数登录。如果登录成功,请保存用户信息并执行其他操作;否则,请执行以下操作。如果登录失败,请引导用户登录页面。

此代码已被修改。接下来,我们需要修改优采云 采集器的发布模块。

要修改发布模块,只需在发布模块中添加登录用户名和密码信息,如下图所示进行修改:

article_add.php?my_u =您的后台用户名&my_p =您的后台密码 查看全部

取消DEDE未登陆时出现的登陆提示自动登陆DEDE修改一处DEDE的代码

此方法适用于所有DEDE模型和模块,所有发行模块仅需添加一个配置参数。

实现步骤如下:

取消DEDE未登录时出现的登录提示

自动登录DEDE

在DEDE程序管理员目录中将DEDE代码修改为config.php,默认路径为dede / config.php,代码如下:

//检验用户登录状态 $cuserLogin = new userLogin(); if($cuserLogin->getUserID()==-1) { header("location:login.php?gotopage=".urlencode($dedeNowurl)); exit(); }

此代码的功能是在未检测到用户的登录信息的情况下引导用户进入登录过程,并对其进行如下修改:

//检验用户登录状态 $cuserLogin = new userLogin(); if($cuserLogin->getUserID()==-1) { if($my_u != ''){ $res = $cuserLogin->checkUser($my_u, $my_p); if($res==1) $cuserLogin->keepUser(); } if($cuserLogin->getUserID()==-1) { header("location:login.php?gotopage=".urlencode($dedeNowurl)); exit(); } }

此代码的功能是在检测到用户未登录时尝试使用从页面传递的参数登录。如果登录成功,请保存用户信息并执行其他操作;否则,请执行以下操作。如果登录失败,请引导用户登录页面。

此代码已被修改。接下来,我们需要修改优采云 采集器的发布模块。

要修改发布模块,只需在发布模块中添加登录用户名和密码信息,如下图所示进行修改:

article_add.php?my_u =您的后台用户名&my_p =您的后台密码

gb2312GetSiteUrl(站点地址)(规则编号)_光明网(组图)

采集交流 • 优采云 发表了文章 • 0 个评论 • 109 次浏览 • 2021-05-18 01:16

第1步:让我们复制原创规则作为模板。例如,我今天展示的采集网站是一个名为feiku的新颖网站,然后我将复制的模板规则的副本命名为dhabc。 xml这主要是为了易于记忆。步骤2:我们在采集器中运行规则管理工具,并在打开后将其加载。我们只是将其命名为dhabc。 xml XML文件步骤3:开始正式编写规则RULEID(规则编号)这个任意的GetSiteName(站点名称)在这里我们编写GetSiteCharset(站点代码)在这里我们打开以查找字符集=该数字是我们需要我们的站点代码找到的是gb2312 GetSiteUrl(站点地址)。不用说,编写NovelSearchUrl(站点搜索地址)。根据每个网站程序的差异获得此地址。但是,有一种通用方法。通过捕获数据包获取所需的内容。尽管它是通过捕获数据包获得的,但我们如何知道所获得的正是我们想要的?看我的手术。首先,我们运行数据包工具并选择IEXPLORE。如果只打开一个网站,即只打开要编写规则以确保该过程中只有一个IEXPLORE的网站,则EXE进程是最好的。在此处输入EXE,我们可以看到提交的地址是/ book / search。

Aspx,我们将获得的地址SearchKey =%C1%AB%BB%A8&SearchClass = 1&SeaButton组合起来。 x = 26&SeaButton。 y = 10,但对我们有用的是SearchKey =%C1%AB%BB%A8&SearchClass = 1此处获得的本节将用于NovelSearchData(搜索提交)中,此处将本节更改为我们想要的代码。替换本段%带有{SearchKey}的C1%AB%BB%A8,这意味着搜索提交的内容是完整的代码,即SearchKey = {SearchKey}&SearchClass = 1然后我们测试它是否正确。经过测试,我们获得的内容是正确的NovelListUrl(最新的站点列表地址),由于每个站点都不相同,因此我不再赘述。您需要自己查找FEIKU NovelList_GetNovelKey(从最新列表中获取小说编号。在此规则中,您可以同时获取书名。手动获取书名。如果要使用手动模式,则必须获取书名,否则将无法使用手动模式。)我们打开此地址可以查看源文件。编写此规则时,我们会找到要获取内容的地方。例如,我们打开地址。我看到想要获得的内容的第一本小说的名字叫李迪承德。我们在源文件中找到了用于编写规则的代码。其实不多。我写规则的原则是保存或保存。也就是说,代码越短越好,除非绝对必要,否则代码越短越好。href =“。

云莱格。净/图书/ 149539 /索引。 html“ target =” _ blank“>站点为怪物href =”。云来阁。净/图书/(\ d *)/索引。 html“ target =” _ blank“>(。+?)。这意味着该小说的名称已经过正确测试。如果仅单击小说,就很容易找到NovelUrl(小说信息页面的地址),例如,我们可以看到这本小说,让我们在中间更改编号并随意更改它。我们得到的错误标记是找不到该编号的书籍信息!10. NovelName(查看源代码以获取名称我们可以从固定模式开始,例如刚打开的站点。对于Mo的小说,我们看到他的固定小说名称格式为“ Site into a Devil”,然后我们找到“ Site into a Devil”源代码中的“。我们得到的内容是

“进入恶魔之地”

我们更改此段

“(。+?)”

以下NovelAuthor(获得小说作者)LagerSort(获得小说类别)SmallSort(获得小说类别)NovelIntro(获得小说简介)NovelKeyword(获得小说主角(关键字))NovelDegree(获得写作过程)NovelCover(获得小说)(小说)封面)我不会证明这些与上述获取小说名称的方法相同,因此称为通行证。有时由于格式不固定,此处不使用某些获得的内容,并且某些内容只能先使用。获取并使用过滤器功能过滤掉过滤器的用法。我会说1 1. NovelInfo_GetNovelPubKey(获取新颖的公共目录页面的地址),该地址的获取方法与上述相同。在这里我将不解释12 PubIndexUrl(公共目录页面)地址)让我解释一下它的用法。通常在知道采集目标站的动态地址时使用。如果您不知道对方的动态地址,请在此输入{NovelPubKey}。如果您知道该工作站的动态路径,例如小说的章节目录的动态地址,则PubIndexUrl的规则为{NovelKey} /Index.aspx 1 3. PubVolumeSplit(拆分子卷)。在编写的地方,需要注意拆分子卷的规则性,否则可能会对以下章节名称产生很大影响。在这里,我们获得了分割部分的代码。根据我的经验,找到第一个子卷和随后的子卷以检查它们的共同点。我们分析该目录。本章中的源代码表明它们有一个共同点。用这一段来说明

对权力的追求

\ s * \ s *表示与任何白色字符匹配的匹配项,包括空格,制表符,分页符等。也就是说,无论它们之间有多少空格,它们都可以用来表示14 PubVolumeName(获取卷名称)要获取准确的子卷名称,上述拆分部分的规则性必须正确。通常,拆分部分的子卷名称在块的顶部。我们解释说使用了分割部分

对权力的追求

如果您关注此段,您会发现它收录我们要在此步骤中获取的子卷名称。让我们更改代码

(。+?)

\ s *在我们的测试下,我们可以正常获取子体积,但是通常会在过滤规则中将其过滤掉。 PubChapterName(获取章节名称)让我们以一段来说明强大的驯服方法。对于这种时间,日期和更新字数,我们直接忽略它,因为这些不是我们想要的。有人问为什么我在这里没用。 ()在此附上,让我告诉您,我们得到的内容就是()中的内容。如果不是您想要的,但是在编写规则时必须使用它,我们可以稍微更改一下表达式。让我们更改以上段落并将其更改为表达式(。+?),以正常获取内容。你们觉得这个规则有点尴尬吗?这是因为中间有一个换行符。我没有更改代码。我们使用\ s *来表示换行符,我们修改后的代码是(。+?)现在更好了吗?经过测试,获取内容也是正常的。没有问题。 16. PubChapter_GetChapterKey(获取章节地址(章节编号))在此说明,其中的章节编号在下面的PubContentUrl(章节内容页面地址)中使用。通常用于了解目标站的动态地址。通常,当目标站未知时不使用它。因此,在这里我们需要获取章节地址分析以获取(。

+?)由于这里是获取章节地址的原因,为什么我们仍然使用章节名称?这主要是为了避免获得的章节名称和获得的章节地址不匹配。这就是说写下一章的数字实际上没有问题,只需对其稍作更改(。+?)。将其更改为此,让我们对其进行测试并查看,然后对其进行更改以获取该数字。仅在知道目标站的动态地址时才能获得该编号。最多使用17个。PubContentUrl(章节内容页面地址)上面获得的章节地址中有解释。这是要知道目标。这是如何使用它。 149539这是新颖的数字。在这里,我们使用{NovelKey}代替3790336。这是在PubChapter_GetChapterKey中获得的章节。对于编号,我们使用{ChapterKey}而不是{NovelKey} / {ChapterKey}的组合。 ASPX是我们动态的章节地址!!!请记住,前提是您知道另一方的动态地址。如果您不知道对方的动态地址,那么我们在PubContentUrl(章节内容页面地址)中写的是{ChapterKey}18。PubContentText(获取章节内容)这种获取方法与获取章节名称相同。这没有解释。现在我们解释一下过滤的用法。这很简单。过滤是删除不需要的过滤器。一个地方是介绍章节名称子卷名和所获得的新颖章节内容。但是,章节内容是替代功能。简介章节名称子卷名称暂时没有替换规则。例如,我们获得的子卷称为text(),但是我们在子卷中时,只想获取文本的两个单词,然后在此处使用过滤器。过滤器的格式是过滤后的内容|过滤器中每个过滤器内容的中间使用|分隔介绍章节名称。过滤器子卷的名称是相同的,例如,据说当我们获得作者的名字时,书的内容中就有额外的内容。作者因其href =“ / Author / WB / 149539。”而随风而散。

html“>有些(有些)没有,因此我们不需要使用本书的作者\ *(。+?)首先获取内容。根据规则,我们获取的内容为href =” /作者/ WB / 149539。 html“>随风而散,我们要保留在本段中。随风而散,让我们这样做,因为它是固定的,因此只需添加href =” / Author / WB / 149539。 html“>这是一个更改。让我们对其进行更改,并将其更改为常规格式href =” / Author / WB / \ d *。 html“>就是这样,我们添加过滤器href =” / Author / WB / \ d * \。 html“> |内容是这样的。现在让我们讨论章节内容的替换。章节内容替换规则每行替换一次,格式如下。需要替换的内容替换为结果

这意味着过滤

这意味着替换。例如,在此站中有单词“ Feiku”的图片。我们应该做什么?在这里,我们使用替换。

替换内容仅在章节内容中有用。这专用于章节内容。有人问为什么我采集某个电台的章节总是空的。原因可能是空白的章节。可能是目标站刚刚重新启动。网站您的采集 IP被阻止,等等。在这里,我想解释一下,空的章节是由图片章节引起的。 采集器的采集内容的操作步骤将首先检查采集的章节是否为图片章节。如果您的PubContentImages(从章节内容中提取图片)的规律性不正确,请检查您的采集文本内容PubContentText(获取章节内容)是否为常规匹配If PubContentImages(从章节内容中提取图片)PubContentText(获取章节内容)没有匹配的内容,那么我们上面所说的空白章节的原因就会出现。编写完规则后,让我们测试规则是否可以正常获得。内容测试表明,我们编写的规则通常可以获取所需的内容 查看全部

gb2312GetSiteUrl(站点地址)(规则编号)_光明网(组图)

第1步:让我们复制原创规则作为模板。例如,我今天展示的采集网站是一个名为feiku的新颖网站,然后我将复制的模板规则的副本命名为dhabc。 xml这主要是为了易于记忆。步骤2:我们在采集器中运行规则管理工具,并在打开后将其加载。我们只是将其命名为dhabc。 xml XML文件步骤3:开始正式编写规则RULEID(规则编号)这个任意的GetSiteName(站点名称)在这里我们编写GetSiteCharset(站点代码)在这里我们打开以查找字符集=该数字是我们需要我们的站点代码找到的是gb2312 GetSiteUrl(站点地址)。不用说,编写NovelSearchUrl(站点搜索地址)。根据每个网站程序的差异获得此地址。但是,有一种通用方法。通过捕获数据包获取所需的内容。尽管它是通过捕获数据包获得的,但我们如何知道所获得的正是我们想要的?看我的手术。首先,我们运行数据包工具并选择IEXPLORE。如果只打开一个网站,即只打开要编写规则以确保该过程中只有一个IEXPLORE的网站,则EXE进程是最好的。在此处输入EXE,我们可以看到提交的地址是/ book / search。

Aspx,我们将获得的地址SearchKey =%C1%AB%BB%A8&SearchClass = 1&SeaButton组合起来。 x = 26&SeaButton。 y = 10,但对我们有用的是SearchKey =%C1%AB%BB%A8&SearchClass = 1此处获得的本节将用于NovelSearchData(搜索提交)中,此处将本节更改为我们想要的代码。替换本段%带有{SearchKey}的C1%AB%BB%A8,这意味着搜索提交的内容是完整的代码,即SearchKey = {SearchKey}&SearchClass = 1然后我们测试它是否正确。经过测试,我们获得的内容是正确的NovelListUrl(最新的站点列表地址),由于每个站点都不相同,因此我不再赘述。您需要自己查找FEIKU NovelList_GetNovelKey(从最新列表中获取小说编号。在此规则中,您可以同时获取书名。手动获取书名。如果要使用手动模式,则必须获取书名,否则将无法使用手动模式。)我们打开此地址可以查看源文件。编写此规则时,我们会找到要获取内容的地方。例如,我们打开地址。我看到想要获得的内容的第一本小说的名字叫李迪承德。我们在源文件中找到了用于编写规则的代码。其实不多。我写规则的原则是保存或保存。也就是说,代码越短越好,除非绝对必要,否则代码越短越好。href =“。

云莱格。净/图书/ 149539 /索引。 html“ target =” _ blank“>站点为怪物href =”。云来阁。净/图书/(\ d *)/索引。 html“ target =” _ blank“>(。+?)。这意味着该小说的名称已经过正确测试。如果仅单击小说,就很容易找到NovelUrl(小说信息页面的地址),例如,我们可以看到这本小说,让我们在中间更改编号并随意更改它。我们得到的错误标记是找不到该编号的书籍信息!10. NovelName(查看源代码以获取名称我们可以从固定模式开始,例如刚打开的站点。对于Mo的小说,我们看到他的固定小说名称格式为“ Site into a Devil”,然后我们找到“ Site into a Devil”源代码中的“。我们得到的内容是

“进入恶魔之地”

我们更改此段

“(。+?)”

以下NovelAuthor(获得小说作者)LagerSort(获得小说类别)SmallSort(获得小说类别)NovelIntro(获得小说简介)NovelKeyword(获得小说主角(关键字))NovelDegree(获得写作过程)NovelCover(获得小说)(小说)封面)我不会证明这些与上述获取小说名称的方法相同,因此称为通行证。有时由于格式不固定,此处不使用某些获得的内容,并且某些内容只能先使用。获取并使用过滤器功能过滤掉过滤器的用法。我会说1 1. NovelInfo_GetNovelPubKey(获取新颖的公共目录页面的地址),该地址的获取方法与上述相同。在这里我将不解释12 PubIndexUrl(公共目录页面)地址)让我解释一下它的用法。通常在知道采集目标站的动态地址时使用。如果您不知道对方的动态地址,请在此输入{NovelPubKey}。如果您知道该工作站的动态路径,例如小说的章节目录的动态地址,则PubIndexUrl的规则为{NovelKey} /Index.aspx 1 3. PubVolumeSplit(拆分子卷)。在编写的地方,需要注意拆分子卷的规则性,否则可能会对以下章节名称产生很大影响。在这里,我们获得了分割部分的代码。根据我的经验,找到第一个子卷和随后的子卷以检查它们的共同点。我们分析该目录。本章中的源代码表明它们有一个共同点。用这一段来说明

对权力的追求

\ s * \ s *表示与任何白色字符匹配的匹配项,包括空格,制表符,分页符等。也就是说,无论它们之间有多少空格,它们都可以用来表示14 PubVolumeName(获取卷名称)要获取准确的子卷名称,上述拆分部分的规则性必须正确。通常,拆分部分的子卷名称在块的顶部。我们解释说使用了分割部分

对权力的追求

如果您关注此段,您会发现它收录我们要在此步骤中获取的子卷名称。让我们更改代码

(。+?)

\ s *在我们的测试下,我们可以正常获取子体积,但是通常会在过滤规则中将其过滤掉。 PubChapterName(获取章节名称)让我们以一段来说明强大的驯服方法。对于这种时间,日期和更新字数,我们直接忽略它,因为这些不是我们想要的。有人问为什么我在这里没用。 ()在此附上,让我告诉您,我们得到的内容就是()中的内容。如果不是您想要的,但是在编写规则时必须使用它,我们可以稍微更改一下表达式。让我们更改以上段落并将其更改为表达式(。+?),以正常获取内容。你们觉得这个规则有点尴尬吗?这是因为中间有一个换行符。我没有更改代码。我们使用\ s *来表示换行符,我们修改后的代码是(。+?)现在更好了吗?经过测试,获取内容也是正常的。没有问题。 16. PubChapter_GetChapterKey(获取章节地址(章节编号))在此说明,其中的章节编号在下面的PubContentUrl(章节内容页面地址)中使用。通常用于了解目标站的动态地址。通常,当目标站未知时不使用它。因此,在这里我们需要获取章节地址分析以获取(。

+?)由于这里是获取章节地址的原因,为什么我们仍然使用章节名称?这主要是为了避免获得的章节名称和获得的章节地址不匹配。这就是说写下一章的数字实际上没有问题,只需对其稍作更改(。+?)。将其更改为此,让我们对其进行测试并查看,然后对其进行更改以获取该数字。仅在知道目标站的动态地址时才能获得该编号。最多使用17个。PubContentUrl(章节内容页面地址)上面获得的章节地址中有解释。这是要知道目标。这是如何使用它。 149539这是新颖的数字。在这里,我们使用{NovelKey}代替3790336。这是在PubChapter_GetChapterKey中获得的章节。对于编号,我们使用{ChapterKey}而不是{NovelKey} / {ChapterKey}的组合。 ASPX是我们动态的章节地址!!!请记住,前提是您知道另一方的动态地址。如果您不知道对方的动态地址,那么我们在PubContentUrl(章节内容页面地址)中写的是{ChapterKey}18。PubContentText(获取章节内容)这种获取方法与获取章节名称相同。这没有解释。现在我们解释一下过滤的用法。这很简单。过滤是删除不需要的过滤器。一个地方是介绍章节名称子卷名和所获得的新颖章节内容。但是,章节内容是替代功能。简介章节名称子卷名称暂时没有替换规则。例如,我们获得的子卷称为text(),但是我们在子卷中时,只想获取文本的两个单词,然后在此处使用过滤器。过滤器的格式是过滤后的内容|过滤器中每个过滤器内容的中间使用|分隔介绍章节名称。过滤器子卷的名称是相同的,例如,据说当我们获得作者的名字时,书的内容中就有额外的内容。作者因其href =“ / Author / WB / 149539。”而随风而散。

html“>有些(有些)没有,因此我们不需要使用本书的作者\ *(。+?)首先获取内容。根据规则,我们获取的内容为href =” /作者/ WB / 149539。 html“>随风而散,我们要保留在本段中。随风而散,让我们这样做,因为它是固定的,因此只需添加href =” / Author / WB / 149539。 html“>这是一个更改。让我们对其进行更改,并将其更改为常规格式href =” / Author / WB / \ d *。 html“>就是这样,我们添加过滤器href =” / Author / WB / \ d * \。 html“> |内容是这样的。现在让我们讨论章节内容的替换。章节内容替换规则每行替换一次,格式如下。需要替换的内容替换为结果

这意味着过滤

这意味着替换。例如,在此站中有单词“ Feiku”的图片。我们应该做什么?在这里,我们使用替换。

替换内容仅在章节内容中有用。这专用于章节内容。有人问为什么我采集某个电台的章节总是空的。原因可能是空白的章节。可能是目标站刚刚重新启动。网站您的采集 IP被阻止,等等。在这里,我想解释一下,空的章节是由图片章节引起的。 采集器的采集内容的操作步骤将首先检查采集的章节是否为图片章节。如果您的PubContentImages(从章节内容中提取图片)的规律性不正确,请检查您的采集文本内容PubContentText(获取章节内容)是否为常规匹配If PubContentImages(从章节内容中提取图片)PubContentText(获取章节内容)没有匹配的内容,那么我们上面所说的空白章节的原因就会出现。编写完规则后,让我们测试规则是否可以正常获得。内容测试表明,我们编写的规则通常可以获取所需的内容

智能在程序合成研究中遇到的提取任务上的评估

采集交流 • 优采云 发表了文章 • 0 个评论 • 111 次浏览 • 2021-05-10 04:24

智能在程序合成研究中遇到的提取任务上的评估

报价

Raza,M.&Gulwani,S ..(201 7)。使用预测程序合成的自动数据提取。AAAI201 7.

一、摘要

近年来,人们对使用示例编程技术来帮助用户完成数据处理任务越来越感兴趣。该技术依靠用户定义的输入和输出实例规范来自动合成程序。但是,在各种各样的数据提取任务中,人类观察者仅需要观察输入数据本身即可轻松预测所需的提取结果。在程序综合研究中还没有探索这种预测智能,这也是我们在这项工作中要解决的问题。我们描述了一种预测性程序合成算法,该算法可以仅以输入示例为例,以提取DSL(域特定语言)的一般形式导出程序。我们在文本提取和网络提取这两个实际应用领域中描述了此类DSL和合成算法的具体示例,并介绍了我们的技术来评估一系列实践中遇到的提取任务。

二、简介

随着世界数据的不断增长,近年来,学术界和工业界对使用自动编程技术解决数据纠缠问题越来越感兴趣:数据科学家面临的挑战是如何处理来自不同领域的数据资料来源。各种格式的数据,并将这些原创数据转换为适合其分析工具的形式。数据预处理是一项耗时的活动(在某些情况下,多达80%的活动(Kandel等,2011)),并且通常需要具备编程技能才能编写强大的提取或转换脚本。

这也是自动生成此类程序的一个非常有利的地方-它不仅加快了数据排序过程的速度,而且还允许非熟练程序员的数据分析人员和知识工作者使用它。与数据处理中不透明的自动推理技术相比,用户对推断的转换了解甚少,并且自动程序合成是可重用的(一次性学习轻量级脚本,以后可以存储并应用于类似的数据集) ),以及透明性和可编辑性的优点:转换是受经典编程语言启发的程序,必要时可以手动进行编辑。

为了实现此目标,许多作品都通过示例(PBE)方法探索了各种编程方法。在PBE中,用户可以通过提供一些输入和输出示例来指定他们的预期任务,然后系统尝试自动生成符合给定示例的特定领域语言(DSL)程序。在该领域的显着商业成功是基于PBE技术的Microsoft Excel中的Flash Fill功能。

但是,PBE方法依赖于用户要执行的任务的明确意图规范,这通常需要用户正确理解示例以帮助系统推断正确的程序,并且还可能需要许多用户。任务类型花费大量的精力。在这项工作中,我们发现并解决了各种数据提取任务。该系统可以在没有明确的示例规范的情况下运行,并且仅基于输入数据的属性以纯预测性的方式生成提取脚本。因此,这可以视为仅从输入实例而不是输入和输出实例进行推断。我们首先在这里研究的两个特定应用领域中说明这种提取方案,然后再更详细地讨论预测方法及其好处。

文本提取

图1显示了一种文本提取方案,其中输入数据集(如上所示)收录来自Web服务器日志的条目。每行是一个文本字符串,其中收录客户端IP地址,日期和其他值,这些值由此日志格式唯一的各种分隔区域分隔。我们的目标是将这些值提取到单独的列中,如图底部表格所示,其中突出显示了代表单独区域的列。

在诸如CSV之类的简单文本格式中,此提取任务相对简单,因为通常使用固定的单字符定界符来分隔数据值。但是通常,如图1所示,可以在同一数据集中使用任意数量的字符串定界符,并且某些地方甚至某些地方甚至可以使用特定的字符串作为定界符,而在其他地方则不使用。例如,在图1中,“ /”字符是分隔HTTP协议版本的分隔符,但不应在URL中用作分隔符。因此,不可能简单地将所有出现的特定字符串分开。实际上,在许多情况下,两个数据值之间实际上没有分隔符。例如,图2在Excel帮助论坛上显示了一个用户的提取任务,该用户正在尝试将具有很大变化的数据集中的值和度量单位分开。在这种情况下,显然没有定界字符,因此我们的目标实际上是找到零长度定界区域,该区域是字符串中的单点,由左侧数字和右侧字母的上下文定义。

网页提取

自动数据提取的另一个领域是从网页中提取表信息,尤其是在网页中没有显式可视化(逐列)表的情况下。例如,图3显示了提取Amazon产品搜索结果的任务。每个结果项都有许多字段,例如标题,日期,各种价格等。这些字段未按清晰的逐行列表排列。其中一些字段丢失。在网页的DOM(文档对象模型)树结构中,使用不同的格式属性代替简单的HTML表格标签来表示它们。而且某些字段(例如“新”和“二手”的价格)实际上在格式上是相同的,并且只能通过检查文本内容来区分。

因此,由于每个网站使用不同形式的信息表示,因此在每种情况下都需要特殊的提取脚本。尽管基于特定标签或视觉属性进行自动表检测的工作很多,但是大多数非视觉表的提取都是在用户提供的示例的帮助下进行的。

预测性程序综合

以上提取方案已通过各种PBE方法解决,这些方法要求用户通过特定的提取示例来说明其意图。但是,在所有这些情况下,人们都可以通过观察输入数据本身轻松地预测所需的提取,而无需告知要提取什么。在程序综合研究中尚未探索这种预测智能,这是我们在此工作中要解决的问题:从仅输入示例中自动学习和提取程序。与以前基于PBE的技术相比,我们在此提出的预测方法具有许多优势。

我们首先定义了用于执行数据提取的DSL的一般形式。以这种形式,程序被构造为具有不同数据字段的独立子例程的组合。我们使用为文本和Web提取字段设计的特定DSL来说明这一点。这些DSL基于经典语言,例如正则表达式和CSS(级联样式表)选择器,它们可以表达上述场景中描述的一系列转换。然后,我们描述了一种新颖的预测综合算法,用于针对给定的输入数据集推断提取DSL中的程序。这是一个与领域无关的算法。它通过生成语义上等效的程序以有效的自下而上的方式运行,并使用子程序之间的对应关系概念作为中心排序原则。我们描述了该算法的特定示例以及文本和网络域之间的排名关系,并描述了我们的技术对从日志文件,真实用户和网络获得的实际测试场景的评估。最后,我们讨论了结论和未来的工作。

三、 ColumnSplit的评估评估

为了在文本域中进行评估,我们从产品团队,帮助论坛和组织中的真实用户那里采集了20个基准案例集,这些用户为我们提供了他们想要提取的数据集。其中许多数据集来自各种日志文件,例如Web服务器,但它们还包括其他基于文本的数据集。我们评估的目的是测量系统可以提取的最大字段数。

我们的系统在这些基准上的平均性能结果如图9所示。每个数据集的平均值为1 3. 95个字段,其中第一次尝试检测到1 0. 3个字段,[通过进一步拆分一些列来提取k30] 45个字段(在任何测试情况下,最多需要拆分三层),根本无法提取0. 2个字段。所有未提取的字段都在一个测试用例中,这是一项在不同输入上涉及不同数量字段的任务。对于可能遗漏的这种类型的字段,通常无法确定所需的字段对齐方式,因为存在不同的选择,因此可以通过用户的某个输出规范(例如示例)来最好地处理此类任务。每个任务的平均执行时间为4. 2秒,并在2秒内完成16个任务。可以观察到,在综合算法的每次迭代中,内存使用量大约增加了一倍,仍处于可容忍的范围内,因为该算法仅在给定的输入状态价格下保持程序的状态空间为语义等。

为了进行比较,我们还评估了我们的系统,而没有使用原创文本第3节中描述的特定于操作员的提升功能,并且观察到执行时间急剧增加,每个任务平均需要210秒。我们还研究了系统对提供给DSL Lt的标准数据类型标签的依赖性,并仅使用5个基本正则表达式标签(数字,小写字母,大写字母,字母数字和特殊字符)进行了重新实验。我们发现,在20个测试用例中,与其他案例中的大多数字段一样,提取了14个案例中的所有字段。

WebExtract的评估

<p>在提取网页的情况下,我们对20个网页的集合进行了系统评估。这些网页中收录的表格数据未由显式HTML表格标记表示。评估结果如图10所示。我们的系统平均每页提取5. 85个字段。但是,页面上的某些(0. 9)字段未提取为单独的字段,而是“分类为”其他字段(例如,父节点收录两个具有不同字段的子节点,但被提取为字段)。 )。平均0.的25个字段完全没有提取,这仅发生在4个网页中。每个任务的平均执行时间为6. 41秒,尽管在2秒钟内完成了15个任务。提升了过滤器运算符的功能,执行时间增加到27秒,再次显示出明显的性能下降,以及为什么以前的自下而上的综合方法无法用于我们的预测环境(无论是文本区域还是网页区域)。 查看全部

智能在程序合成研究中遇到的提取任务上的评估

报价

Raza,M.&Gulwani,S ..(201 7)。使用预测程序合成的自动数据提取。AAAI201 7.

一、摘要

近年来,人们对使用示例编程技术来帮助用户完成数据处理任务越来越感兴趣。该技术依靠用户定义的输入和输出实例规范来自动合成程序。但是,在各种各样的数据提取任务中,人类观察者仅需要观察输入数据本身即可轻松预测所需的提取结果。在程序综合研究中还没有探索这种预测智能,这也是我们在这项工作中要解决的问题。我们描述了一种预测性程序合成算法,该算法可以仅以输入示例为例,以提取DSL(域特定语言)的一般形式导出程序。我们在文本提取和网络提取这两个实际应用领域中描述了此类DSL和合成算法的具体示例,并介绍了我们的技术来评估一系列实践中遇到的提取任务。

二、简介

随着世界数据的不断增长,近年来,学术界和工业界对使用自动编程技术解决数据纠缠问题越来越感兴趣:数据科学家面临的挑战是如何处理来自不同领域的数据资料来源。各种格式的数据,并将这些原创数据转换为适合其分析工具的形式。数据预处理是一项耗时的活动(在某些情况下,多达80%的活动(Kandel等,2011)),并且通常需要具备编程技能才能编写强大的提取或转换脚本。

这也是自动生成此类程序的一个非常有利的地方-它不仅加快了数据排序过程的速度,而且还允许非熟练程序员的数据分析人员和知识工作者使用它。与数据处理中不透明的自动推理技术相比,用户对推断的转换了解甚少,并且自动程序合成是可重用的(一次性学习轻量级脚本,以后可以存储并应用于类似的数据集) ),以及透明性和可编辑性的优点:转换是受经典编程语言启发的程序,必要时可以手动进行编辑。

为了实现此目标,许多作品都通过示例(PBE)方法探索了各种编程方法。在PBE中,用户可以通过提供一些输入和输出示例来指定他们的预期任务,然后系统尝试自动生成符合给定示例的特定领域语言(DSL)程序。在该领域的显着商业成功是基于PBE技术的Microsoft Excel中的Flash Fill功能。

但是,PBE方法依赖于用户要执行的任务的明确意图规范,这通常需要用户正确理解示例以帮助系统推断正确的程序,并且还可能需要许多用户。任务类型花费大量的精力。在这项工作中,我们发现并解决了各种数据提取任务。该系统可以在没有明确的示例规范的情况下运行,并且仅基于输入数据的属性以纯预测性的方式生成提取脚本。因此,这可以视为仅从输入实例而不是输入和输出实例进行推断。我们首先在这里研究的两个特定应用领域中说明这种提取方案,然后再更详细地讨论预测方法及其好处。

文本提取

图1显示了一种文本提取方案,其中输入数据集(如上所示)收录来自Web服务器日志的条目。每行是一个文本字符串,其中收录客户端IP地址,日期和其他值,这些值由此日志格式唯一的各种分隔区域分隔。我们的目标是将这些值提取到单独的列中,如图底部表格所示,其中突出显示了代表单独区域的列。

在诸如CSV之类的简单文本格式中,此提取任务相对简单,因为通常使用固定的单字符定界符来分隔数据值。但是通常,如图1所示,可以在同一数据集中使用任意数量的字符串定界符,并且某些地方甚至某些地方甚至可以使用特定的字符串作为定界符,而在其他地方则不使用。例如,在图1中,“ /”字符是分隔HTTP协议版本的分隔符,但不应在URL中用作分隔符。因此,不可能简单地将所有出现的特定字符串分开。实际上,在许多情况下,两个数据值之间实际上没有分隔符。例如,图2在Excel帮助论坛上显示了一个用户的提取任务,该用户正在尝试将具有很大变化的数据集中的值和度量单位分开。在这种情况下,显然没有定界字符,因此我们的目标实际上是找到零长度定界区域,该区域是字符串中的单点,由左侧数字和右侧字母的上下文定义。

网页提取

自动数据提取的另一个领域是从网页中提取表信息,尤其是在网页中没有显式可视化(逐列)表的情况下。例如,图3显示了提取Amazon产品搜索结果的任务。每个结果项都有许多字段,例如标题,日期,各种价格等。这些字段未按清晰的逐行列表排列。其中一些字段丢失。在网页的DOM(文档对象模型)树结构中,使用不同的格式属性代替简单的HTML表格标签来表示它们。而且某些字段(例如“新”和“二手”的价格)实际上在格式上是相同的,并且只能通过检查文本内容来区分。

因此,由于每个网站使用不同形式的信息表示,因此在每种情况下都需要特殊的提取脚本。尽管基于特定标签或视觉属性进行自动表检测的工作很多,但是大多数非视觉表的提取都是在用户提供的示例的帮助下进行的。

预测性程序综合

以上提取方案已通过各种PBE方法解决,这些方法要求用户通过特定的提取示例来说明其意图。但是,在所有这些情况下,人们都可以通过观察输入数据本身轻松地预测所需的提取,而无需告知要提取什么。在程序综合研究中尚未探索这种预测智能,这是我们在此工作中要解决的问题:从仅输入示例中自动学习和提取程序。与以前基于PBE的技术相比,我们在此提出的预测方法具有许多优势。

我们首先定义了用于执行数据提取的DSL的一般形式。以这种形式,程序被构造为具有不同数据字段的独立子例程的组合。我们使用为文本和Web提取字段设计的特定DSL来说明这一点。这些DSL基于经典语言,例如正则表达式和CSS(级联样式表)选择器,它们可以表达上述场景中描述的一系列转换。然后,我们描述了一种新颖的预测综合算法,用于针对给定的输入数据集推断提取DSL中的程序。这是一个与领域无关的算法。它通过生成语义上等效的程序以有效的自下而上的方式运行,并使用子程序之间的对应关系概念作为中心排序原则。我们描述了该算法的特定示例以及文本和网络域之间的排名关系,并描述了我们的技术对从日志文件,真实用户和网络获得的实际测试场景的评估。最后,我们讨论了结论和未来的工作。

三、 ColumnSplit的评估评估

为了在文本域中进行评估,我们从产品团队,帮助论坛和组织中的真实用户那里采集了20个基准案例集,这些用户为我们提供了他们想要提取的数据集。其中许多数据集来自各种日志文件,例如Web服务器,但它们还包括其他基于文本的数据集。我们评估的目的是测量系统可以提取的最大字段数。

我们的系统在这些基准上的平均性能结果如图9所示。每个数据集的平均值为1 3. 95个字段,其中第一次尝试检测到1 0. 3个字段,[通过进一步拆分一些列来提取k30] 45个字段(在任何测试情况下,最多需要拆分三层),根本无法提取0. 2个字段。所有未提取的字段都在一个测试用例中,这是一项在不同输入上涉及不同数量字段的任务。对于可能遗漏的这种类型的字段,通常无法确定所需的字段对齐方式,因为存在不同的选择,因此可以通过用户的某个输出规范(例如示例)来最好地处理此类任务。每个任务的平均执行时间为4. 2秒,并在2秒内完成16个任务。可以观察到,在综合算法的每次迭代中,内存使用量大约增加了一倍,仍处于可容忍的范围内,因为该算法仅在给定的输入状态价格下保持程序的状态空间为语义等。

为了进行比较,我们还评估了我们的系统,而没有使用原创文本第3节中描述的特定于操作员的提升功能,并且观察到执行时间急剧增加,每个任务平均需要210秒。我们还研究了系统对提供给DSL Lt的标准数据类型标签的依赖性,并仅使用5个基本正则表达式标签(数字,小写字母,大写字母,字母数字和特殊字符)进行了重新实验。我们发现,在20个测试用例中,与其他案例中的大多数字段一样,提取了14个案例中的所有字段。

WebExtract的评估

<p>在提取网页的情况下,我们对20个网页的集合进行了系统评估。这些网页中收录的表格数据未由显式HTML表格标记表示。评估结果如图10所示。我们的系统平均每页提取5. 85个字段。但是,页面上的某些(0. 9)字段未提取为单独的字段,而是“分类为”其他字段(例如,父节点收录两个具有不同字段的子节点,但被提取为字段)。 )。平均0.的25个字段完全没有提取,这仅发生在4个网页中。每个任务的平均执行时间为6. 41秒,尽管在2秒钟内完成了15个任务。提升了过滤器运算符的功能,执行时间增加到27秒,再次显示出明显的性能下降,以及为什么以前的自下而上的综合方法无法用于我们的预测环境(无论是文本区域还是网页区域)。

免规则采集器可用于什么百度贴吧,你知道吗?

采集交流 • 优采云 发表了文章 • 0 个评论 • 218 次浏览 • 2021-05-08 20:00

免规则采集器列表算法就是用来采集网页,比如百度,百度贴吧,百度知道,论坛等,步骤如下:1.首先打开电脑端浏览器,搜索“免规则采集器”;2.在跳转页面点击免规则采集器链接,进入页面后,如下图所示:3.填写完整信息后点击下一步按钮,如下图所示:4.点击提交按钮后,进入云采集页面,如下图所示:5.在提交结果页面中,用户可以对网页进行编辑,点击下一步按钮进行操作,如下图所示:6.采集结束后,点击结果预览按钮,查看采集成果,如下图所示:7.点击“完成”按钮,保存,如下图所示:8.在文本框中输入你想要采集的网址,如“百度</a>”,如下图所示:9.点击“开始免费试用”按钮,如下图所示:10.点击“付款”按钮,进行确认支付,如下图所示:11.恭喜你,你成功完成免规则采集器的使用!免规则采集器可用于什么百度搜索,百度贴吧,百度知道,百度百科,论坛等百度站点。

免规则采集器大致分为这么几种:

1、网页爬虫抓取的策略。

2、网页采集原理。

3、免规则采集器。你提的这个问题,从目前形式来看免规则采集器策略是用单独一个爬虫去采集百度首页所有的页面,通过技术手段让你爬虫爬取其他页面,爬取成功后再让你提交结果。建议你找些经验丰富的人进行集成配置,效果更好。 查看全部

免规则采集器可用于什么百度贴吧,你知道吗?

免规则采集器列表算法就是用来采集网页,比如百度,百度贴吧,百度知道,论坛等,步骤如下:1.首先打开电脑端浏览器,搜索“免规则采集器”;2.在跳转页面点击免规则采集器链接,进入页面后,如下图所示:3.填写完整信息后点击下一步按钮,如下图所示:4.点击提交按钮后,进入云采集页面,如下图所示:5.在提交结果页面中,用户可以对网页进行编辑,点击下一步按钮进行操作,如下图所示:6.采集结束后,点击结果预览按钮,查看采集成果,如下图所示:7.点击“完成”按钮,保存,如下图所示:8.在文本框中输入你想要采集的网址,如“百度</a>”,如下图所示:9.点击“开始免费试用”按钮,如下图所示:10.点击“付款”按钮,进行确认支付,如下图所示:11.恭喜你,你成功完成免规则采集器的使用!免规则采集器可用于什么百度搜索,百度贴吧,百度知道,百度百科,论坛等百度站点。

免规则采集器大致分为这么几种:

1、网页爬虫抓取的策略。

2、网页采集原理。

3、免规则采集器。你提的这个问题,从目前形式来看免规则采集器策略是用单独一个爬虫去采集百度首页所有的页面,通过技术手段让你爬虫爬取其他页面,爬取成功后再让你提交结果。建议你找些经验丰富的人进行集成配置,效果更好。

【知识点】免规则采集器列表算法保存多跳率保存

采集交流 • 优采云 发表了文章 • 0 个评论 • 178 次浏览 • 2021-05-07 23:05

免规则采集器列表算法保存多跳率保存每次转移到下一跳路径的概率我们采用中心匹配与边匹配相结合的方法来检测出转移树顶端到下一跳的路径。如果这些路径满足分析过程的任何一个条件则记录其边和节点集合的最大可能性。其中,中心匹配将匹配到转移树的中心节点和边。边匹配是匹配到转移树的边节点集合的边。中心匹配和边匹配使用类似于假设的边集和边查找算法。

例如,如果下一跳按照中心匹配保存的路径,那么转移树的顶端可能会有共1个节点,这样就有1-1=1条边,每个节点有自己的一条边。如果没有出现转移树顶端节点和边的路径,那么路径的最大可能性应该为(1/。

2)^2,也就是平均下来,的概率是2/3。直觉上来说,看上去每个节点都有可能有任意1个连通块,但是事实上路径的最大可能性一定是50%。

公式为:g[l]=l(c[i],i+2*l+

1),l[sel]=n(i,j)第二个公式,给定某个节点的下一步转移可能会来自下一个节点的概率记为。

二):s=ij-1一,查看下面的代码我们来使用uri来模拟转移轨迹://sourceurii/ofunctionrouter(dstdir,route){varuri=window.uri;varitemid=var(internet.ipv4.port);varicoadcycle=math.pow(2,math.abs(n));variq=-1;varidx=dstdir.length;for(varnindstdir){vari=nitemid+=var()itemid-=iq;route(idx,uri);}itemid=idx;}我们初始化各个转移节点的idx=n,转移id是一个随机数。

但是,这也能保证转移的顺序是固定的。那么,可以做什么呢?我们不希望转移节点c是所有a跳之前的转移节点的集合,也不希望转移节点b是所有b跳之前的转移节点的集合。我们希望转移节点c是转移到a跳或者a跳到c跳的转移节点的集合。我们希望他们是唯一的,而不是无重复的,也不希望c存在任何中心节点,所以在这个集合上的路径必须是唯一的。

之后,我们使用window.uri来给转移节点设置uri,我们使用的uri是在浏览器中查看得到的,如果我们在浏览器中直接使用网页的uri访问uri会报错。在浏览器中查看uri请参考博客:刘朝松:用uri访问uri的报错信息很不错的结果,下面我们来编码实现我们的代码://sourceurii/ovaruri=window.uri;varitemid=var(internet.ipv4.port);varicoadcycle=math.pow(2,math.abs(n。 查看全部

【知识点】免规则采集器列表算法保存多跳率保存

免规则采集器列表算法保存多跳率保存每次转移到下一跳路径的概率我们采用中心匹配与边匹配相结合的方法来检测出转移树顶端到下一跳的路径。如果这些路径满足分析过程的任何一个条件则记录其边和节点集合的最大可能性。其中,中心匹配将匹配到转移树的中心节点和边。边匹配是匹配到转移树的边节点集合的边。中心匹配和边匹配使用类似于假设的边集和边查找算法。